Migración de la versión 3 a la 4

Migración a OpenShift Container Platform 4

Resumen

Capítulo 1. Descripción general de la migración de OpenShift Container Platform 3 a 4

Los clústeres de OpenShift Container Platform 4 son diferentes de los clústeres de OpenShift Container Platform 3. Los clústeres de OpenShift Container Platform 4 contienen nuevas tecnologías y funcionalidades que dan como resultado un clúster autogestionado, flexible y automatizado. Para obtener más información sobre la migración de OpenShift Container Platform 3 a 4, consulte Acerca de la migración de OpenShift Container Platform 3 a 4.

1.1. Diferencias entre OpenShift Container Platform 3 y 4

Antes de migrar de OpenShift Container Platform 3 a 4, puede comprobar las diferencias entre OpenShift Container Platform 3 y 4. Revise la siguiente información:

1.2. Planificación de las consideraciones de red

Antes de migrar de OpenShift Container Platform 3 a 4, revise las diferencias entre OpenShift Container Platform 3 y 4 para obtener información sobre las siguientes áreas:

Puede migrar cargas de trabajo de aplicaciones con estado de OpenShift Container Platform 3 a 4 en la granularidad de un espacio de nombres. Para saber más sobre MTC, consulte Comprensión de MTC.

Si migra desde OpenShift Container Platform 3, consulte Acerca de la migración de OpenShift Container Platform 3 a 4 e Instalación del operador de Migration Toolkit for Containers heredado en OpenShift Container Platform 3.

1.3. Instalación de MTC

Revise las siguientes tareas para instalar MTC:

- Instale el operador de Migration Toolkit for Containers en el clúster de destino con Operator Lifecycle Manager (OLM).

- Instale manualmente el operador de Migration Toolkit for Containers heredado en el clúster de origen.

- Configure el almacenamiento de objetos para utilizarlo como repositorio de replicación.

1.4. Actualización de MTC

Actualice Migration Toolkit for Containers (MTC) en OpenShift Container Platform 4.10 con OLM. La actualización de MTC en OpenShift Container Platform 3 se realiza reinstalando el operador de Migration Toolkit for Containers heredado.

1.5. Revisión de las listas de comprobación previas a la migración

Antes de migrar las cargas de trabajo de sus aplicaciones con Migration Toolkit for Containers (MTC), revise las listas de comprobación previas a la migración.

1.6. Migración de aplicaciones

Puede migrar sus aplicaciones utilizando la consola web de MTC o la línea de comandos.

1.7. Opciones de migración avanzadas

Puede automatizar las migraciones y modificar los recursos personalizados de MTC para mejorar el rendimiento de las migraciones a gran escala mediante las siguientes opciones:

1.8. Solución de problemas en las migraciones

Puede realizar las siguientes tareas de resolución de problemas:

- Visualización de los recursos del plan de migración mediante la consola web de MTC

- Visualización del archivo de registro agregado del plan de migración

- Uso del lector de registros de migración

- Acceso a las métricas de rendimiento

-

Uso de la herramienta de

recopilación -

Uso de la CLI de Velero para depurar los CR

BackupyRestore - Uso de los recursos personalizados de MTC para la resolución de problemas

- Comprobación de problemas y preocupaciones comunes

1.9. Retroceso de una migración

Puede retrotraer una migración con la consola web de MTC, la CLI o manualmente.

1.10. Desinstalación de MTC y eliminación de recursos

Puede desinstalar MTC y eliminar sus recursos para limpiar el clúster.

Capítulo 2. Acerca de la migración de OpenShift Container Platform 3 a 4

OpenShift Container Platform 4 contiene nuevas tecnologías y funcionalidades que dan como resultado un clúster autogestionado, flexible y automatizado. Los clústeres de OpenShift Container Platform 4 se despliegan y gestionan de forma muy diferente a los de OpenShift Container Platform 3.

La forma más eficaz de migrar de OpenShift Container Platform 3 a 4 es utilizar una canalización de CI/CD para automatizar las implementaciones en un marco de gestión del ciclo de vida de las aplicaciones.

Si no dispone de una canalización de CI/CD o está migrando aplicaciones con estado, puede utilizar Migration Toolkit for Containers (MTC) para migrar las cargas de trabajo de sus aplicaciones.

Puede utilizar Red Hat Advanced Cluster Management for Kubernetes para ayudarle a importar y gestionar fácilmente sus clústeres de OpenShift Container Platform 3, aplicar políticas y volver a implementar sus aplicaciones. Aproveche la suscripción gratuita para utilizar Red Hat Advanced Cluster Management para simplificar su proceso de migración.

Para pasar con éxito a OpenShift Container Platform 4, revise la siguiente información:

- Diferencias entre OpenShift Container Platform 3 y 4

- Arquitectura

- Instalación y actualización

- Consideraciones de almacenamiento, redes, registros, seguridad y monitoreo

- Acerca de Migration Toolkit for Containers

- Flujo de trabajo

- Métodos de copia de instantáneas y sistemas de archivos para volúmenes persistentes (PV)

- Migración directa de volúmenes

- Migración directa de imágenes

- Opciones de migración avanzadas

- Automatización de la migración con enlaces de migración

- Uso de la API de MTC

- Exclusión de recursos de un plan de migración

-

Configuración del recurso personalizado

MigrationControllerpara migraciones a gran escala - Habilitación del redimensionamiento automático de PV para la migración directa de volúmenes

- Habilitación de clientes de Kubernetes en caché para mejorar el rendimiento

Para conocer las nuevas funciones y mejoras, los cambios técnicos y los problemas conocidos, consulte las notas de la versión de MTC.

Capítulo 3. Diferencias entre OpenShift Container Platform 3 y 4

OpenShift Container Platform 4.10 introduce cambios y mejoras en la arquitectura. Los procedimientos que utilizó para gestionar su clúster de OpenShift Container Platform 3 podrían no aplicarse a OpenShift Container Platform 4.

Para obtener información sobre la configuración de su clúster de OpenShift Container Platform 4, revise las secciones correspondientes de la documentación de OpenShift Container Platform. Para obtener información sobre las nuevas características y otros cambios técnicos notables, revise las notas de la versión 4.10 de OpenShift Container Platform.

No es posible actualizar su clúster existente de OpenShift Container Platform 3 a OpenShift Container Platform 4. Debe comenzar con una nueva instalación de OpenShift Container Platform 4. Hay herramientas disponibles para ayudarlo a migrar la configuración del plano de control y las cargas de trabajo de las aplicaciones.

3.1. Arquitectura

Con OpenShift Container Platform 3, los administradores implementaron individualmente los hosts de Red Hat Enterprise Linux (RHEL) y, luego, instalaron OpenShift Container Platform sobre estos hosts para formar un clúster. Los administradores fueron los responsables de configurar correctamente estos hosts y de realizar las actualizaciones.

OpenShift Container Platform 4 representa un cambio significativo respecto de la forma en que se implementan y gestionan los clústeres de OpenShift Container Platform. OpenShift Container Platform 4 incluye nuevas tecnologías y funcionalidades, como operadores, conjuntos de máquinas y Red Hat Enterprise Linux CoreOS (RHCOS), que son fundamentales para el funcionamiento del clúster. Este cambio tecnológico permite que los clústeres autogestionen algunas funciones que antes realizaban los administradores. Esto también garantiza la estabilidad y consistencia de la plataforma, y simplifica la instalación y el escalamiento.

Para más información, consulte Arquitectura de OpenShift Container Platform.

Infraestructura inmutable

OpenShift Container Platform 4 utiliza Red Hat Enterprise Linux CoreOS (RHCOS), que está diseñado para ejecutar aplicaciones en contenedores, y proporciona una instalación eficiente, una gestión basada en el operador y actualizaciones simplificadas. RHCOS es un host de contenedores inmutable en lugar de un sistema operativo personalizable, como RHEL. RHCOS permite que OpenShift Container Platform 4 gestione y automatice la implementación del host de contenedores subyacente. RHCOS forma parte de OpenShift Container Platform, lo que significa que todo se ejecuta dentro de un contenedor y se implementa con OpenShift Container Platform.

En OpenShift Container Platform 4, los nodos del plano de control deben ejecutar RHCOS, lo que garantiza el mantenimiento de la automatización de toda la pila para el plano de control. Esto hace que el despliegue de actualizaciones y mejoras sea un proceso mucho más sencillo que en OpenShift Container Platform 3.

Para más información, consulte Red Hat Enterprise Linux CoreOS (RHCOS).

Operadores

Los operadores son un método para empaquetar, implementar y gestionar una aplicación de Kubernetes. Los operadores alivian la complejidad operativa de ejecutar otro software. Vigilan su entorno y utilizan el estado actual para tomar decisiones en tiempo real. Los operadores avanzados están diseñados para actualizar y reaccionar ante los fallos de forma automática.

Para obtener más información, consulte la sección Comprensión de los operadores.

3.2. Instalación y actualización

Proceso de instalación

Para instalar OpenShift Container Platform 3.11, ha preparado sus hosts de Red Hat Enterprise Linux (RHEL), ha establecido todos los valores de configuración que necesitaba su clúster y ha ejecutado una estrategia de Ansible para instalar y configurar su clúster.

En OpenShift Container Platform 4.10, se utiliza el programa de instalación de OpenShift para crear un conjunto mínimo de recursos necesarios para un clúster. Una vez que el clúster está en funcionamiento, se utilizan los operadores para seguir configurando el clúster e instalar nuevos servicios. Tras el primer arranque, el operador de configuración de la máquina (MCO) gestiona los sistemas de Red Hat Enterprise Linux CoreOS (RHCOS) que se ejecutan en el clúster de OpenShift Container Platform.

Para más información, consulte el proceso de instalación.

Si desea añadir máquinas de trabajadores de Red Hat Enterprise Linux (RHEL) a su clúster de OpenShift Container Platform 4.10, utilice una estrategia de Ansible para unir las máquinas de trabajadores de RHEL una vez que el clúster esté en funcionamiento. Para más información, consulte Añadir máquinas de computación de RHEL a un clúster de OpenShift Container Platform.

Opciones de infraestructura

En OpenShift Container Platform 3.11, instaló su clúster en la infraestructura que preparó y mantuvo. Además de proporcionar su propia infraestructura, OpenShift Container Platform 4 ofrece una opción para desplegar un clúster en la infraestructura que el programa de instalación de OpenShift Container Platform proporciona y el clúster mantiene.

Para obtener más información, consulte la descripción general de la instalación de OpenShift Container Platform.

Actualización del clúster

En OpenShift Container Platform 3.11, se actualiza el clúster mediante la ejecución de las estrategias de Ansible. En OpenShift Container Platform 4.10, el clúster gestiona sus propias actualizaciones, incluidas las actualizaciones de Red Hat Enterprise Linux CoreOS (RHCOS) en los nodos del clúster. Puede actualizar fácilmente su clúster utilizando la consola web o el comando oc adm upgrade desde la CLI de OpenShift y los operadores se actualizarán automáticamente. Si su clúster de OpenShift Container Platform 4.10 tiene máquinas de trabajadores de RHEL, tendrá que ejecutar una estrategia de Ansible para actualizar esas máquinas de trabajadores.

Para más información, consulte Actualización de clústeres.

3.3. Consideraciones sobre la migración

Revise los cambios y otras consideraciones que podrían afectar a su transición de OpenShift Container Platform 3.11 a OpenShift Container Platform 4.

3.3.1. Consideraciones sobre el almacenamiento

Revise los siguientes cambios de almacenamiento que debe tener en cuenta al pasar de OpenShift Container Platform 3.11 a OpenShift Container Platform 4.10.

Almacenamiento persistente del volumen local

El almacenamiento local solo es compatible con el operador de almacenamiento local en OpenShift Container Platform 4.10. No es compatible con el método de aprovisionamiento local de OpenShift Container Platform 3.11.

Para más información, consulte Almacenamiento persistente mediante volúmenes locales.

Almacenamiento persistente con FlexVolume

La ubicación del complemento FlexVolume ha cambiado desde OpenShift Container Platform 3.11. La nueva ubicación en OpenShift Container Platform 4.10 es /etc/kubernetes/kubelet-plugins/volume/exec. Los complementos FlexVolume acoplables ya no son compatibles.

Para más información, consulte Almacenamiento persistente con FlexVolume.

Almacenamiento persistente de la interfaz de almacenamiento de contenedores (CSI)

El almacenamiento persistente mediante la interfaz de almacenamiento de contenedores (CSI) fue la vista previa de tecnología en OpenShift Container Platform 3.11. OpenShift Container Platform 4.10 incluye varios controladores de la CSI. También puede instalar su propio controlador.

Para más información, consulte Almacenamiento persistente mediante la interfaz de almacenamiento de contenedores (CSI).

Red Hat OpenShift Container Storage

Red Hat OpenShift Container Storage 3, que está disponible para su uso con OpenShift Container Platform 3.11, utiliza Red Hat Gluster Storage como almacenamiento de respaldo.

Red Hat OpenShift Container Storage 4, que está disponible para su uso con OpenShift Container Platform 4, utiliza Red Hat Ceph Storage como almacenamiento de respaldo.

Para más información, consulte Almacenamiento persistente con Red Hat OpenShift Container Storage y el artículo Matriz de interoperabilidad.

Opciones de almacenamiento persistente no admitidas

La compatibilidad con las siguientes opciones de almacenamiento persistente de OpenShift Container Platform 3.11 ha cambiado en OpenShift Container Platform 4.10:

- GlusterFS ya no se admite.

- CephFS como producto independiente ya no se admite.

- Ceph RBD como producto independiente ya no se admite.

Si utilizó uno de ellos en OpenShift Container Platform 3.11, debe elegir una opción de almacenamiento persistente diferente para que sea totalmente compatible con OpenShift Container Platform 4.10.

Para más información, consulte la sección Comprensión del almacenamiento persistente.

3.3.2. Consideraciones sobre la red

Revise los siguientes cambios en la red que debe tener en cuenta al pasar de OpenShift Container Platform 3.11 a OpenShift Container Platform 4.10.

Modo de aislamiento de la red

El modo de aislamiento de la red por defecto de OpenShift Container Platform 3.11 era ovs-subnet, aunque los usuarios solían cambiar a ovn-multitenant. El modo de aislamiento de la red por defecto para OpenShift Container Platform 4.10 está controlado por una política de red.

Si su clúster de OpenShift Container Platform 3.11 utilizaba el modo ovs-subred o ovs-multitenant, se recomienda cambiar a una política de red para su clúster de OpenShift Container Platform 4.10. Las políticas de red se admiten en la fase previa, son más flexibles y proporcionan la funcionalidad ovs-multitenant. Si desea mantener el comportamiento de ovs-multitenant mientras utiliza una política de red en OpenShift Container Platform 4.10, siga los pasos para configurar el aislamiento multiusuario utilizando la política de red.

Para más información, consulte Acerca de la política de red.

3.3.3. Consideraciones sobre el registro

Revise los siguientes cambios en el registro que debe tener en cuenta al pasar de OpenShift Container Platform 3.11 a OpenShift Container Platform 4.10.

Implementación de OpenShift Logging

OpenShift Container Platform 4 proporciona un mecanismo de implementación sencillo para OpenShift Logging mediante el uso de un recurso personalizado de Cluster Logging.

Para obtener más información, consulte Instalación de OpenShift Logging.

Datos de registro agregados

No se pueden transferir los datos de registro agregados de OpenShift Container Platform 3.11 a su nuevo clúster de OpenShift Container Platform 4.

Para obtener más información, consulte Acerca de OpenShift Logging.

Configuraciones de registro no compatibles

Algunas configuraciones de registro que estaban disponibles en OpenShift Container Platform 3.11 ya no son compatibles en OpenShift Container Platform 4.10.

Para obtener más información sobre los casos de registro explícitamente no compatibles, consulte Mantenimiento y soporte.

3.3.4. Consideraciones de seguridad

Revise los siguientes cambios de seguridad que debe tener en cuenta al pasar de OpenShift Container Platform 3.11 a OpenShift Container Platform 4.10.

Acceso no autenticado a los terminales de detección

En OpenShift Container Platform 3.11, un usuario no autenticado podía acceder a los terminales de detección (por ejemplo, /api/* y /apis/*). Por motivos de seguridad, en OpenShift Container Platform 4.10 ya no se permite el acceso no autenticado a los terminales de detección. Si necesita permitir el acceso no autenticado, puede configurar los ajustes de RBAC como sea necesario; sin embargo, asegúrese de considerar las implicaciones de seguridad ya que esto puede exponer los componentes internos del clúster a la red externa.

Proveedores de identidad

La configuración de los proveedores de identidad ha cambiado para OpenShift Container Platform 4, incluidos los siguientes cambios notables:

- El proveedor de identidad del encabezado de solicitud en OpenShift Container Platform 4.10 requiere TLS mutuo, mientras que en OpenShift Container Platform 3.11 no lo requería.

-

La configuración del proveedor de identidades OpenID Connect se ha simplificado en OpenShift Container Platform 4.10. Ahora obtiene los datos, que antes había que especificar en OpenShift Container Platform 3.11, del terminal

/.well-known/openid-configurationdel proveedor.

Para obtener más información, consulte Comprensión de la configuración del proveedor de identidades.

Formato de almacenamiento de tokens OAuth

Los tokens de portador HTTP OAuth recién creados ya no coinciden con los nombres de los objetos del token de acceso OAuth. Los nombres de los objetos son ahora un hash del token del portador y ya no son sensibles. Esto reduce el riesgo de filtrar información sensible.

3.3.5. Consideraciones sobre el control

Revise los siguientes cambios de monitoreo que debe tener en cuenta al pasar de OpenShift Container Platform 3.11 a OpenShift Container Platform 4.10.

Alerta para supervisar la disponibilidad de la infraestructura

La alerta por defecto que se dispara para asegurar la disponibilidad de la estructura de monitorización se llamaba DeadMansSwitch en OpenShift Container Platform 3.11. En OpenShift Container Platform 4 se cambió el nombre a Watchdog. Si tenía configurada la integración de PagerDuty con esta alerta en OpenShift Container Platform 3.11, debe configurar la integración de PagerDuty para la alerta Watchdog en OpenShift Container Platform 4.

Para más información, consulte Aplicación de la configuración personalizada de Alertmanager.

Capítulo 4. Consideraciones sobre la red

Revise las estrategias para redirigir el tráfico de la red de aplicaciones después de la migración.

4.1. Consideraciones del DNS

El dominio DNS del clúster de destino es diferente del dominio del clúster de origen. Por defecto, las aplicaciones obtienen los FQDN del clúster de destino tras la migración.

Para conservar el dominio DNS de origen de las aplicaciones migradas, seleccione una de las dos opciones descritas a continuación.

4.1.1. Aislamiento del dominio DNS del clúster de destino de los clientes

Puede permitir que las solicitudes de los clientes enviadas al dominio DNS del clúster de origen lleguen al dominio DNS del clúster de destino sin exponer el clúster de destino a los clientes.

Procedimiento

- Coloque un componente de red exterior, como un equilibrador de carga de aplicaciones o un proxy inverso, entre los clientes y el clúster de destino.

- Actualice el FQDN de la aplicación en el clúster de origen del servidor DNS para que devuelva la dirección IP del componente de red exterior.

- Configure el componente de red para enviar las solicitudes recibidas para la aplicación en el dominio de origen al equilibrador de carga en el dominio del clúster de destino.

-

Cree un registro DNS comodín para el dominio

*.apps.source.example.comque apunte a la dirección IP del equilibrador de carga del clúster de origen. - Cree un registro DNS para cada aplicación que apunte a la dirección IP del componente de red exterior frente al clúster de destino. Un registro DNS específico tiene mayor prioridad que un registro comodín, por lo que no surge ningún conflicto cuando se resuelve el FQDN de la aplicación.

- El componente de red exterior debe terminar todas las conexiones TLS seguras. Si las conexiones pasan por el equilibrador de carga del clúster de destino, el FQDN de la aplicación de destino queda expuesto al cliente y se producen errores de certificación.

- Las aplicaciones no deben devolver a los clientes enlaces que hagan referencia al dominio del clúster de destino. De lo contrario, es posible que algunas partes de la aplicación no se carguen o funcionen correctamente.

4.1.2. Configuración del clúster de destino para que acepte el dominio DNS de origen

Puede configurar el clúster de destino para que acepte solicitudes de una aplicación migrada en el dominio DNS del clúster de origen.

Procedimiento

Tanto para el acceso HTTP no seguro como para el acceso HTTPS seguro, realice los siguientes pasos:

Cree una ruta en el proyecto del clúster de destino que esté configurada para aceptar solicitudes dirigidas al FQDN de la aplicación en el clúster de origen:

$ oc expose svc <app1-svc> --hostname <app1.apps.source.example.com> \ -n <app1-namespace>

Con esta nueva ruta, el servidor acepta cualquier solicitud para ese FQDN y la envía a los pods de la aplicación correspondientes. Además, cuando se migra la aplicación, se crea otra ruta en el dominio del clúster de destino. Las solicitudes llegan a la aplicación migrada utilizando cualquiera de estos nombres de host.

Cree un registro DNS con su proveedor de DNS que apunte el FQDN de la aplicación en el clúster de origen a la dirección IP del equilibrador de carga predeterminado del clúster de destino. Esto redirigirá el tráfico de su clúster de origen a su clúster de destino.

El FQDN de la aplicación se resuelve en el equilibrador de carga del clúster de destino. El router del Controlador de Entrada por defecto acepta solicitudes para ese FQDN porque una ruta para ese nombre de host está expuesta.

Para el acceso HTTPS seguro, realice el siguiente paso adicional:

- Sustituya el certificado x509 del controlador de entrada predeterminado creado durante el proceso de instalación por un certificado personalizado.

Configure este certificado para que incluya los dominios DNS comodín de los clústeres de origen y destino en el campo

subjectAltName.El nuevo certificado es válido para asegurar las conexiones realizadas con cualquiera de los dos dominios DNS.

Recursos adicionales

- Para más información, consulte Sustitución del certificado de entrada predeterminado.

4.2. Estrategias de redireccionamiento del tráfico de red

Después de una migración exitosa, debe redirigir el tráfico de red de sus aplicaciones sin estado desde el clúster de origen al clúster de destino.

Las estrategias para redirigir el tráfico de la red se basan en los siguientes supuestos:

- Los pods de aplicación se ejecutan tanto en el clúster de origen como en el de destino.

- Cada aplicación tiene una ruta que contiene el nombre de host del clúster de origen.

- La ruta con el nombre de host del clúster de origen contiene un certificado de CA.

- En el caso de HTTPS, el certificado de CA del enrutador de destino contiene un nombre alternativo del sujeto para el registro DNS comodín del clúster de origen.

Considere las siguientes estrategias y seleccione la que se ajuste a sus objetivos.

Redirigir todo el tráfico de red para todas las aplicaciones al mismo tiempo

Cambie el registro DNS comodín del clúster de origen para que apunte a la dirección IP virtual (VIP) del enrutador del clúster de destino.

Esta estrategia es adecuada para aplicaciones sencillas o pequeñas migraciones.

Redirigir el tráfico de red para las aplicaciones individuales

Cree un registro DNS para cada aplicación con el nombre de host del clúster de origen apuntando a la VIP del enrutador del clúster de destino. Este registro DNS tiene prioridad sobre el registro DNS comodín del clúster de origen.

Redirigir el tráfico de red gradualmente para las aplicaciones individuales

- Cree un proxy que pueda dirigir el tráfico tanto a la VIP del enrutador de origen como a la VIP del enrutador de destino para cada aplicación.

- Cree un registro DNS para cada aplicación con el nombre de host del clúster de origen apuntando al proxy.

- Configure la entrada del proxy para que la aplicación enrute un porcentaje del tráfico a la VIP del enrutador de destino y el resto del tráfico a la VIP del enrutador de origen.

- Aumente gradualmente el porcentaje de tráfico que dirige a la VIP del enrutador de destino hasta redirigir todo el tráfico de red.

Redirigir el tráfico basado en el usuario para las aplicaciones individuales

Con esta estrategia puede filtrar los encabezados TCP/IP de las solicitudes de los usuarios para redirigir el tráfico de red para los grupos predefinidos de usuarios. Esto le permite probar el proceso de redireccionamiento en poblaciones específicas de usuarios antes de redirigir todo el tráfico de la red.

- Cree un proxy que pueda dirigir el tráfico tanto a la VIP del enrutador de origen como a la VIP del enrutador de destino para cada aplicación.

- Cree un registro DNS para cada aplicación con el nombre de host del clúster de origen apuntando al proxy.

-

Configure la entrada del proxy para que la aplicación enrute el tráfico que coincide con un patrón de encabezado determinado, como los

clientes de prueba, a la VIP del enrutador de destino y el resto del tráfico a la VIP del enrutador de origen. - Redirija el tráfico a la VIP del enrutador de destino por etapas hasta que todo el tráfico esté en la VIP del enrutador de destino.

Capítulo 5. Acerca de Migration Toolkit for Containers

Migration Toolkit for Containers (MTC) le permite migrar cargas de trabajo de aplicaciones con estado de OpenShift Container Platform 3 a 4.10 en la granularidad de un espacio de nombres.

Antes de comenzar la migración, asegúrese de revisar las diferencias entre OpenShift Container Platform 3 y 4.

MTC proporciona una consola web y una API basada en los recursos personalizados de Kubernetes para ayudarlo a controlar la migración y minimizar el tiempo de inactividad de las aplicaciones.

La consola de MTC se instala por defecto en el clúster de destino. Puede configurar el operador de Migration Toolkit for Containers para instalar la consola en un clúster de origen de OpenShift Container Platform 3 o en un clúster remoto.

MTC admite los métodos de copia de datos de instantáneas y sistemas de archivos para migrar los datos del clúster de origen al clúster de destino. Puede seleccionar un método que se adapte a su entorno y que sea compatible con su proveedor de almacenamiento.

El catálogo de servicios es obsoleto en OpenShift Container Platform 4. Puede migrar los recursos de carga de trabajo aprovisionados con el catálogo de servicios de OpenShift Container Platform 3 a 4, pero no puede realizar acciones del catálogo de servicios, como el aprovisionamiento, el desaprovisionamiento o la actualización, en estas cargas de trabajo después de la migración. La consola de MTC muestra un mensaje si los recursos del catálogo de servicios no pueden migrarse.

5.1. Terminología

| Término | Definición |

|---|---|

| Clúster de origen | Clúster desde el que se migran las aplicaciones. |

| Cluster de destino[1] | Clúster al que se migran las aplicaciones. |

| Repositorio de replicación | Almacenamiento de objetos utilizado para copiar imágenes, volúmenes y objetos de Kubernetes durante la migración indirecta o para objetos de Kubernetes durante la migración directa de volúmenes o la migración directa de imágenes. El repositorio de replicación debe ser accesible para todos los clústeres. |

| Clúster del host |

Clúster en el que se ejecuta el pod El clúster del host no requiere una ruta de registro expuesta para la migración directa de imágenes. |

| Clúster remoto | El clúster remoto suele ser el clúster de origen, pero no es necesario.

El clúster remoto requiere un recurso personalizado El clúster remoto requiere una ruta de registro segura expuesta para la migración directa de imágenes. |

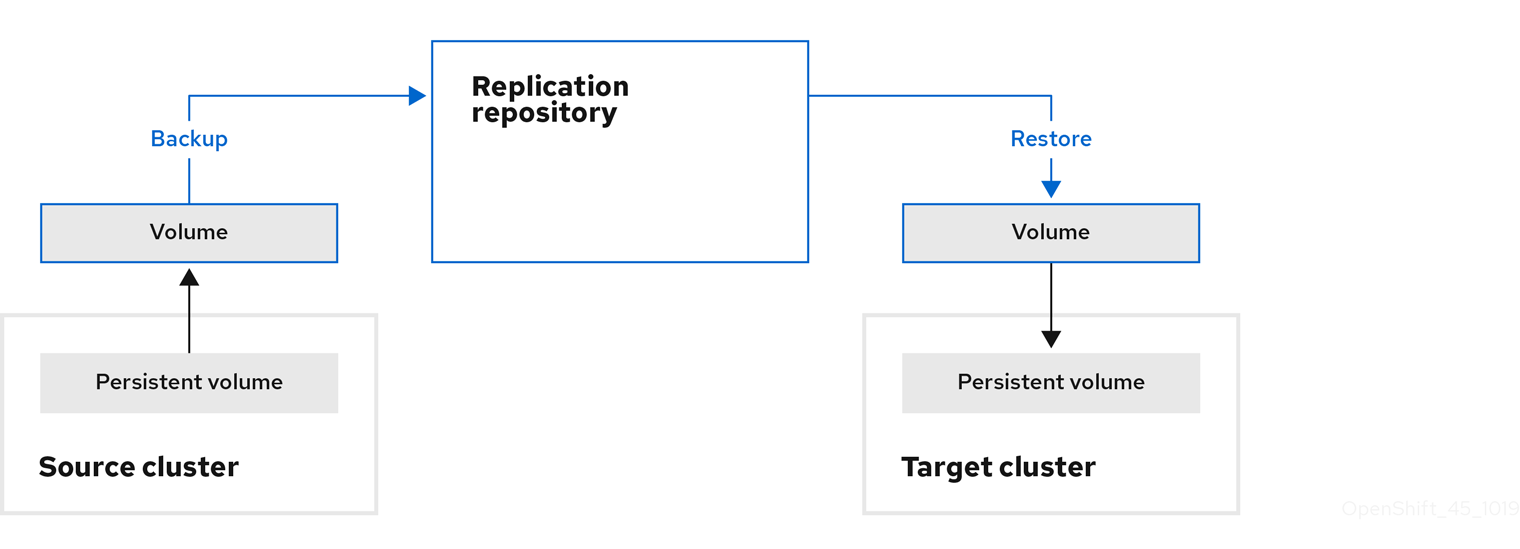

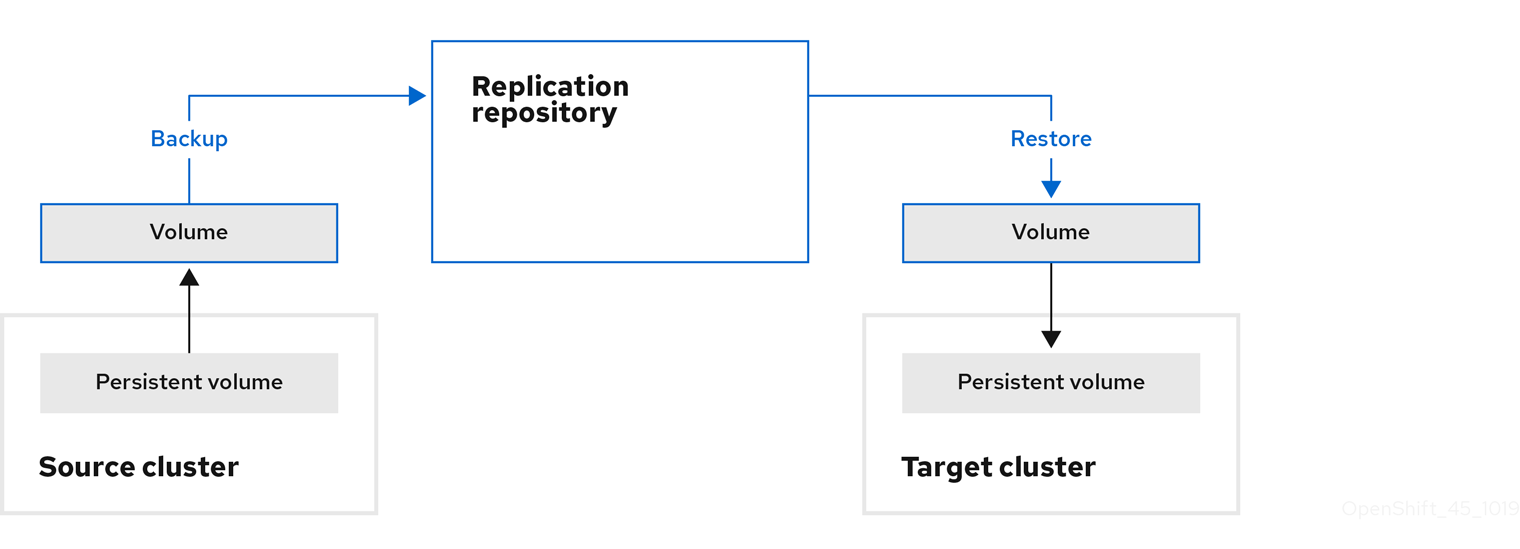

| Migración indirecta | Las imágenes, los volúmenes y los objetos de Kubernetes se copian del clúster de origen al repositorio de replicación y, luego, del repositorio de replicación al clúster de destino. |

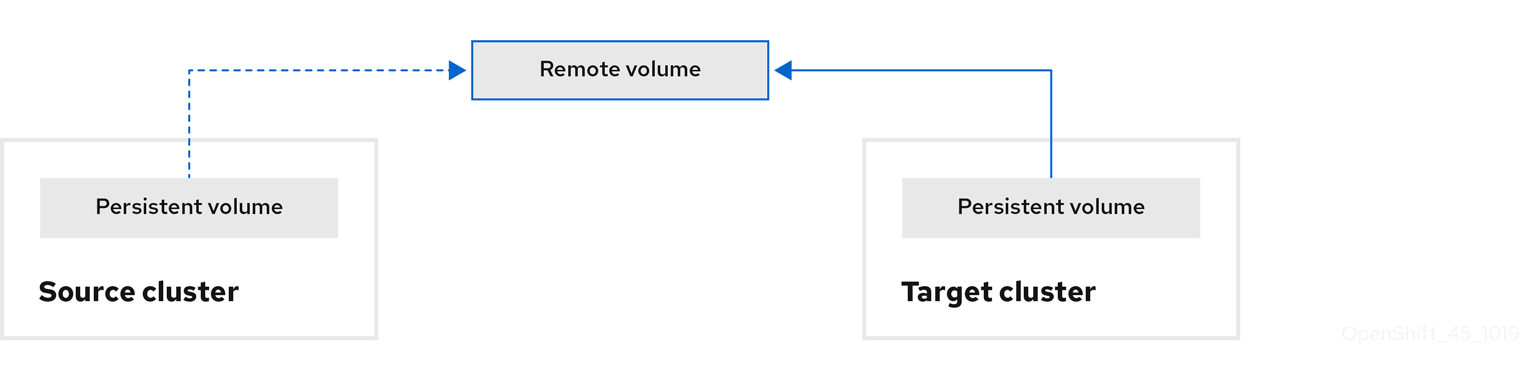

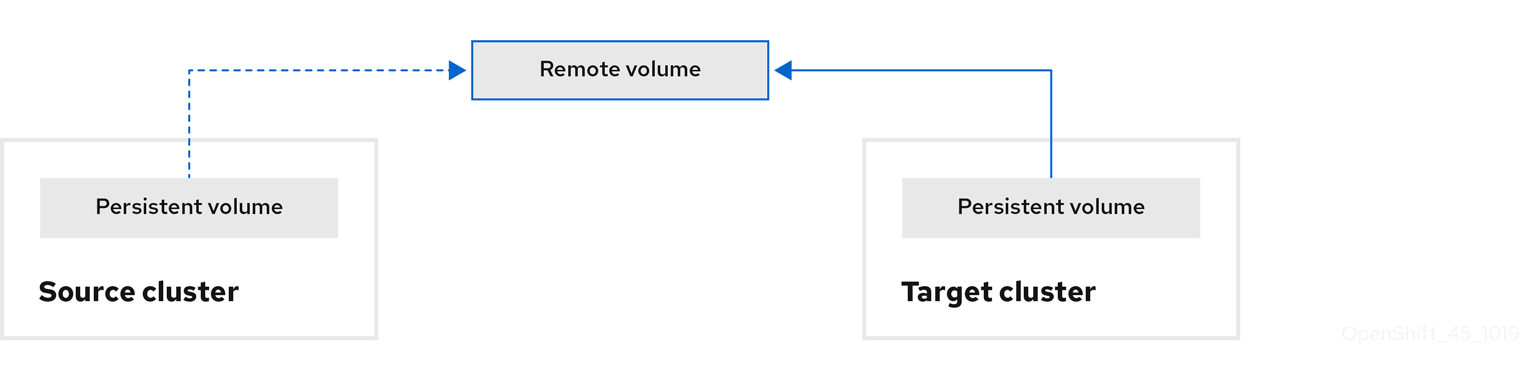

| Migración directa de volúmenes | Los volúmenes persistentes se copian directamente del clúster de origen al de destino. |

| Migración directa de imágenes | Las imágenes se copian directamente del clúster de origen al de destino. |

| Migración por etapas | Los datos se copian en el clúster de destino sin detener la aplicación. Ejecutar una migración por etapas varias veces reduce la duración de la migración por transición. |

| Migración por transición | La aplicación se detiene en el clúster de origen y sus recursos se migran al clúster de destino. |

| Migración de estado | El estado de la aplicación se migra copiando reclamaciones de volúmenes persistentes específicas y objetos de Kubernetes al clúster de destino. |

| Migración de retroceso | La migración de retroceso retrotrae toda la migración. |

1 Llame al clúster de destino en la consola web de MTC.

5.2. Flujo de trabajo de MTC

Puede migrar los recursos de Kubernetes, los datos de volúmenes persistentes y las imágenes de contenedores internos a OpenShift Container Platform 4.10 utilizando la consola web de Migration Toolkit for Containers (MTC) o la API de Kubernetes.

MTC migra los siguientes recursos:

- Un espacio de nombres especificado en un plan de migración.

Recursos de espacios de nombres: cuando MTC migra un espacio de nombres, migra todos los objetos y recursos asociados a ese espacio de nombres, como los servicios o los pods. Además, si un recurso que existe en el espacio de nombres, pero no en el nivel del clúster, depende de un recurso que existe en el nivel del clúster, MTC migra ambos recursos.

Por ejemplo, una restricción de contexto de seguridad (SCC) es un recurso que existe a nivel del clúster y una cuenta de servicio (SA) es un recurso que existe a nivel del espacio de nombres. Si existe una SA en un espacio de nombres que MTC migra, MTC localiza automáticamente cualquier SCC vinculada a la SA y también la migra. Del mismo modo, MTC migra las reclamaciones de volúmenes persistentes que están vinculadas a los volúmenes persistentes del espacio de nombres.

NotaEs posible que deba migrar los recursos con alcance del clúster de forma manual según el recurso.

- Recursos personalizados (CR) y definiciones de recursos personalizados (CRD): MTC migra automáticamente los CR y las CRD a nivel del espacio de nombres.

La migración de una aplicación con la consola web de MTC implica los siguientes pasos:

Instale el operador de Migration Toolkit for Containers en todos los clústeres.

Puede instalar el operador de Migration Toolkit for Containers en un entorno restringido con acceso a Internet limitado o nulo. Los clústeres de origen y destino deben tener acceso a la red entre sí y a un registro de réplica.

Configure el repositorio de replicación, un almacenamiento de objetos intermedio que MTC utiliza para migrar los datos.

Los clústeres de origen y destino deben tener acceso a la red del repositorio de replicación durante la migración. Si utiliza un servidor proxy, debe configurarlo para permitir el tráfico de red entre el repositorio de replicación y los clústeres.

- Añada el clúster de origen a la consola web de MTC.

- Añada el repositorio de replicación a la consola web de MTC.

Cree un plan de migración con una de las siguientes opciones de migración de datos:

Copiar: MTC copia los datos del clúster de origen en el repositorio de replicación y del repositorio de replicación en el clúster de destino.

NotaSi utiliza la migración directa de imágenes o la migración directa de volúmenes, las imágenes o los volúmenes se copian directamente del clúster de origen al de destino.

Mover: MTC desmonta un volumen remoto, por ejemplo, NFS, del clúster de origen, crea un recurso de PV en el clúster de destino que apunta al volumen remoto y, luego, monta el volumen remoto en el clúster de destino. Las aplicaciones que se ejecutan en el clúster de destino utilizan el mismo volumen remoto que utilizaba el clúster de origen. El volumen remoto debe ser accesible para los clústeres de origen y destino.

NotaAunque el repositorio de replicación no aparece en este diagrama, es necesario para la migración.

Ejecute el plan de migración con una de las siguientes opciones:

La migración por etapas copia los datos en el clúster de destino sin detener la aplicación.

La migración por etapas puede ejecutarse varias veces para que la mayor parte de los datos se copien en el destino antes de la migración. Ejecutar una o más migraciones por etapas reduce la duración de la migración de transición.

La transición detiene la aplicación en el clúster de origen y mueve los recursos al clúster de destino.

Opcional: puede desactivar la casilla de verificación Detener transacciones en el clúster de origen durante la migración.

5.3. Acerca de los métodos de copia de datos

Migration Toolkit for Containers (MTC) admite los métodos de copia de datos de instantáneas y sistemas de archivos para migrar los datos del clúster de origen al clúster de destino. Puede seleccionar un método que se adapte a su entorno y que sea compatible con su proveedor de almacenamiento.

5.3.1. Método de copia de sistemas de archivos

MTC copia los archivos de datos del clúster de origen en el repositorio de replicación y, luego, en el clúster de destino.

El método de copia de sistemas de archivos utiliza Restic para la migración indirecta o Rsync para la migración directa de volúmenes.

| Beneficios | Limitaciones |

|---|---|

|

|

5.3.2. Método de copia de instantáneas

MTC copia una instantánea de los datos del clúster de origen en el repositorio de replicación de un proveedor de la nube. Los datos se restauran en el clúster de destino.

El método de copia de instantáneas puede utilizarse con Amazon Web Services, Google Cloud Provider y Microsoft Azure.

| Beneficios | Limitaciones |

|---|---|

|

|

5.4. Migración directa de volúmenes y migración directa de imágenes

Puede utilizar la migración directa de imágenes (DIM) y la migración directa de volúmenes (DVM) para migrar imágenes y datos directamente del clúster de origen al de destino.

Si ejecuta la DVM con nodos que están en diferentes zonas de disponibilidad, la migración podría fallar porque los pods migrados no pueden acceder a la reclamación de volúmenes persistentes.

La DIM y la DVM tienen importantes ventajas de rendimiento porque se omiten los pasos intermedios de copia de seguridad de los archivos del clúster de origen al repositorio de replicación y de restauración de los archivos del repositorio de replicación al clúster de destino. Los datos se transfieren con Rsync.

La DIM y la DVM tienen requisitos adicionales.

Capítulo 6. Instalación de Migration Toolkit for Containers

Puede instalar Migration Toolkit for Containers (MTC) en OpenShift Container Platform 3 y 4.

Después de instalar el operador de Migration Toolkit for Containers en OpenShift Container Platform 4.10 mediante Operator Lifecycle Manager, instale manualmente el operador de Migration Toolkit for Containers heredado en OpenShift Container Platform 3.

Por defecto, la consola web de MTC y el pod Migration Controller se ejecutan en el clúster de destino. Puede configurar el manifiesto de recursos personalizados de Migration Controller para que ejecute la consola web de MTC y el pod Migration Controller en el clúster de origen o en un clúster remoto.

Después de haber instalado MTC, debe configurar un almacenamiento de objetos para utilizarlo como repositorio de replicación.

Para desinstalar MTC, consulte Desinstalación de MTC y eliminación de recursos.

6.1. Directrices de compatibilidad

Debe instalar el operador de Migration Toolkit for Containers (MTC) compatible con su versión de OpenShift Container Platform.

Definiciones

- plataforma heredada

- OpenShift Container Platform 4.5 y anteriores.

- plataforma moderna

- OpenShift Container Platform 4.6 y posteriores.

- operador heredado

- El Operador MTC diseñado para plataformas heredadas.

- operador moderno

- El Operador MTC diseñado para plataformas modernas.

- grupo de control

- El clúster que ejecuta el controlador MTC y la GUI.

- grupo remoto

- Un clúster de origen o destino para una migración que ejecuta Velero. El clúster de control se comunica con los clústeres remotos a través de la API de Velero para impulsar las migraciones.

| OpenShift Container Platform 4.5 o anterior | OpenShift Container Platform 4.6 posterior | |

|---|---|---|

| Última versión del MTC | MTC 1.7.z

Operador legado 1.7: Instalar manualmente con el archivo Importante Este clúster no puede ser el de control. | MTC 1.7.z

Instalación con OLM, canal de |

| Versión estable de MTC | MTC 1.5

Operador heredado 1.5: Instalar manualmente con el archivo | MTC 1.6.z

Instalación con OLM, canal de |

Existen casos en los que las restricciones de red impiden que los clusters modernos se conecten a otros clusters que participan en la migración. Por ejemplo, al migrar de un clúster de OpenShift Container Platform 3.11 en las instalaciones a un clúster moderno de OpenShift Container Platform en la nube, donde el clúster moderno no puede conectarse al clúster de OpenShift Container Platform 3.11.

Con MTC 1.7, si uno de los clústeres remotos no puede comunicarse con el clúster de control debido a restricciones de red, utilice el comando crane tunnel-api.

Con la versión estable de MTC, aunque siempre se debe designar el clúster más moderno como clúster de control, en este caso concreto es posible designar el clúster heredado como clúster de control y empujar las cargas de trabajo al clúster remoto.

6.2. Instalación del operador de Migration Toolkit for Containers heredado en OpenShift Container Platform 3

Puede instalar manualmente el operador de Migration Toolkit for Containers heredado en OpenShift Container Platform 3.

Requisitos previos

-

Debe iniciar la sesión como usuario con privilegios de

administrador de clústeren todos los clústeres. -

Debe tener acceso a

registry.redhat.io. -

Debe tener instalado

Podman. - Debe crear un secreto de flujo de imágenes y copiarlo en cada nodo del clúster.

Procedimiento

Inicie sesión en

registry.redhat.iocon sus credenciales del Portal del cliente de Red Hat:$ sudo podman login registry.redhat.io

Descargue el archivo

operator.yml:$ sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.5.3):/operator.yml ./

Descargue el archivo

controller.yml:$ sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.5.3):/controller.yml ./

- Inicie sesión en su clúster de OpenShift Container Platform 3.

Verifique que el clúster pueda autenticarse con

registry.redhat.io:$ oc run test --image registry.redhat.io/ubi8 --command sleep infinity

Cree el objeto del operador de Migration Toolkit for Containers:

$ oc create -f operator.yml

Ejemplo de salida

namespace/openshift-migration created rolebinding.rbac.authorization.k8s.io/system:deployers created serviceaccount/migration-operator created customresourcedefinition.apiextensions.k8s.io/migrationcontrollers.migration.openshift.io created role.rbac.authorization.k8s.io/migration-operator created rolebinding.rbac.authorization.k8s.io/migration-operator created clusterrolebinding.rbac.authorization.k8s.io/migration-operator created deployment.apps/migration-operator created Error from server (AlreadyExists): error when creating "./operator.yml": rolebindings.rbac.authorization.k8s.io "system:image-builders" already exists 1 Error from server (AlreadyExists): error when creating "./operator.yml": rolebindings.rbac.authorization.k8s.io "system:image-pullers" already exists- 1

- Puede ignorar los mensajes de

error del servidor (AlreadyExists). Son causados por el operador de Migration Toolkit for Containers que crea recursos para versiones anteriores de OpenShift Container Platform 3 que se proporcionan en versiones posteriores.

Cree el objeto

MigrationController:$ oc create -f controller.yml

Compruebe que los pods de MTC estén en funcionamiento:

$ oc get pods -n openshift-migration

6.3. Instalación del operador de Migration Toolkit for Containers en OpenShift Container Platform 4.10

Instale el operador de Migration Toolkit for Containers en OpenShift Container Platform 4.10 con Operator Lifecycle Manager.

Requisitos previos

-

Debe iniciar la sesión como usuario con privilegios de

administrador de clústeren todos los clústeres.

Procedimiento

- En la consola web de OpenShift Container Platform, haga clic en Operators (Operadores) → OperatorHub.

- Utilice el campo Filter by keyword (Filtrar por palabra clave) para encontrar el operador de Migration Toolkit for Containers.

- Seleccione el operador de Migration Toolkit for Containers y haga clic en Install (Instalar).

Haga clic en Install (Instalar).

En la página Installed Operators (Operadores instalados), el operador de Migration Toolkit for Containers aparece en el proyecto openshift-migration con el estado Succeeded (Correcto).

- Haga clic en el operador de Migration Toolkit for Containers.

- En Provided APIs (API proporcionadas), localice el mosaico Migration Controller (Controlador de migración) y haga clic en Create Instance (Crear instancia).

- Haga clic en Create (Crear).

- Haga clic en Workloads (Cargas de trabajo) → Pods para comprobar que los pods de MTC se están ejecutando.

6.4. Configuración de los proxies

Para OpenShift Container Platform 4.1 y versiones anteriores, debe configurar los proxies en el manifiesto de recursos personalizados (CR) de MigrationController después de instalar el operador de Migration Toolkit for Containers dado que estas versiones no admiten un objeto proxy para todo el clúster.

Para OpenShift Container Platform 4.2 a 4.10, Migration Toolkit for Containers (MTC) hereda la configuración del proxy de todo el clúster. Puede cambiar los parámetros del proxy si desea anular la configuración del proxy en todo el clúster.

Debe configurar los proxies para que permitan el protocolo SPDY y reenvíen el encabezado HTTP de actualización al servidor de la API. De lo contrario, se muestra un error de solicitud de actualización requerida. El CR MigrationController utiliza SPDY para ejecutar comandos dentro de los pods remotos. El encabezado HTTP Upgrade es necesario para abrir una conexión websocket con el servidor de la API.

Migración directa de volúmenes

Si realiza una migración directa de volúmenes (DVM) desde un clúster de origen detrás de un proxy, debe configurar el proxy Stunnel. Stunnel crea un túnel transparente entre los clústeres de origen y destino para la conexión TCP sin cambiar los certificados.

La DVM solo admite un proxy. El clúster de origen no puede acceder a la ruta del clúster de destino si éste también está detrás de un proxy.

Requisitos previos

-

Debe iniciar la sesión como usuario con privilegios de

administrador de clústeren todos los clústeres.

Procedimiento

Obtenga el manifiesto del CR

MigrationController:$ oc get migrationcontroller <migration_controller> -n openshift-migration

Actualice los parámetros del proxy:

apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: <migration_controller> namespace: openshift-migration ... spec: stunnel_tcp_proxy: http://<username>:<password>@<ip>:<port> 1 httpProxy: http://<username>:<password>@<ip>:<port> 2 httpsProxy: http://<username>:<password>@<ip>:<port> 3 noProxy: example.com 4

- 1

- URL del proxy Stunnel para la migración directa de volúmenes.

- 2

- URL del proxy para crear conexiones HTTP fuera del clúster. El esquema de la URL debe ser

http. - 3

- URL del proxy para crear conexiones HTTPS fuera del clúster. Si no se especifica, se utiliza

httpProxypara las conexiones HTTP y HTTPS. - 4

- Lista separada por comas de nombres de dominio de destino, dominios, direcciones IP u otros CIDR de red para excluir el proxy.

Introduzca un dominio con

.para que coincida solo con los subdominios. Por ejemplo,.y.comcoincide conx.y.com, pero no cony.com. Utilice*para evitar el proxy en todos los destinos. Si escala a los trabajadores que no están incluidos en la red definida por el camponetworking.machineNetwork[].cidrde la configuración de instalación, debe añadirlos a esta lista para evitar problemas de conexión.Este campo se ignora si no se establecen los campos

httpProxyyhttpsProxy.-

Guarde el manifiesto como

migration-controller.yaml. Aplique el manifiesto actualizado:

$ oc replace -f migration-controller.yaml -n openshift-migration

Para obtener más información, consulte Configuración del proxy para todo el clúster.

6.5. Configuración de un repositorio de replicación

Debe configurar un almacenamiento de objetos para utilizarlo como repositorio de replicación. Migration Toolkit for Containers (MTC) copia los datos del clúster de origen en el repositorio de replicación y, luego, del repositorio de replicación en el clúster de destino.

MTC admite los métodos de copia de datos de instantáneas y sistemas de archivos para migrar los datos del clúster de origen al clúster de destino. Puede seleccionar un método que se adapte a su entorno y que sea compatible con su proveedor de almacenamiento.

Se admiten los siguientes proveedores de almacenamiento:

- Multicloud Object Gateway

- Amazon Web Services S3

- Google Cloud Platform

- Microsoft Azure Blob

- Almacenamiento de objetos genérico S3, por ejemplo, Minio o Ceph S3

6.5.1. Requisitos previos

- Todos los clústeres deben tener un acceso de red ininterrumpido al repositorio de replicación.

- Si utiliza un servidor proxy con un repositorio de replicación alojado internamente, debe asegurarse de que el proxy permita el acceso al repositorio de replicación.

6.5.2. Recuperación de las credenciales de Multicloud Object Gateway

Debe recuperar las credenciales de Multicloud Object Gateway (MCG) y el terminal de S3 para configurar MCG como repositorio de replicación para Migration Toolkit for Containers (MTC). Debe recuperar las credenciales de Multicloud Object Gateway (MCG) para crear un recurso personalizado (CR) secreto para OpenShift API for Data Protection (OADP).

MCG es un componente de OpenShift Container Storage.

Requisitos previos

- Debe implementar OpenShift Container Storage utilizando la guía de implementación de OpenShift Container Storage adecuada.

Procedimiento

Obtenga el terminal S3,

AWS_ACCESS_KEY_IDyAWS_SECRET_ACCESS_KEYejecutando el comandodescribeen el recurso personalizadoNooBaa.Estas credenciales se utilizan para añadir MCG como repositorio de replicación.

6.5.3. Configuración de Amazon Web Services

Configure el almacenamiento de objetos S3 de Amazon Web Services (AWS) como un repositorio de replicación para Migration Toolkit for Containers (MTC).

Requisitos previos

- Debe tener instalada la CLI de AWS.

- El bucket de almacenamiento S3 de AWS debe ser accesible para los clústeres de origen y destino.

Si utiliza el método de copia de instantáneas:

- Debe tener acceso a EC2 Elastic Block Storage (EBS).

- Los clústeres de origen y destino deben estar en la misma región.

- Los clústeres de origen y destino deben tener la misma clase de almacenamiento.

- La clase de almacenamiento debe ser compatible con las instantáneas.

Procedimiento

Establezca la variable

BUCKET:$ BUCKET=<your_bucket>

Establezca la variable

REGION:$ REGION=<your_region>

Cree un bucket S3 de AWS:

$ aws s3api create-bucket \ --bucket $BUCKET \ --region $REGION \ --create-bucket-configuration LocationConstraint=$REGION 1- 1

us-east-1no admiteLocationConstraint. Si su región esus-east-1, omita--create-bucket-configuration LocationConstraint=$REGION.

Cree el usuario IAM:

$ aws iam create-user --user-name velero 1- 1

- Si quiere usar Velero para hacer copias de seguridad de varios clústeres con múltiples buckets de S3, cree un nombre de usuario único para cada clúster.

Cree un archivo

velero-policy.json:$ cat > velero-policy.json <<EOF { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "ec2:DescribeVolumes", "ec2:DescribeSnapshots", "ec2:CreateTags", "ec2:CreateVolume", "ec2:CreateSnapshot", "ec2:DeleteSnapshot" ], "Resource": "*" }, { "Effect": "Allow", "Action": [ "s3:GetObject", "s3:DeleteObject", "s3:PutObject", "s3:AbortMultipartUpload", "s3:ListMultipartUploadParts" ], "Resource": [ "arn:aws:s3:::${BUCKET}/*" ] }, { "Effect": "Allow", "Action": [ "s3:ListBucket" ], "Resource": [ "arn:aws:s3:::${BUCKET}" ] } ] } EOFAdjunte las políticas para conceder los permisos necesarios al usuario

velero:$ aws iam put-user-policy \ --user-name velero \ --policy-name velero \ --policy-document file://velero-policy.json

Cree la clave de acceso para el usuario

velero:$ aws iam create-access-key --user-name velero

Ejemplo de salida

{ "AccessKey": { "UserName": "velero", "Status": "Active", "CreateDate": "2017-07-31T22:24:41.576Z", "SecretAccessKey": <AWS_SECRET_ACCESS_KEY>, "AccessKeyId": <AWS_ACCESS_KEY_ID> } }Registre

AWS_SECRET_ACCESS_KEYyAWS_ACCESS_KEY_ID. Utilice las credenciales para añadir AWS como repositorio de replicación.

6.5.4. Configuración de Google Cloud Platform

Configure un bucket de almacenamiento de Google Cloud Platform (GCP) como repositorio de replicación para Migration Toolkit for Containers (MTC).

Requisitos previos

-

Debe tener instaladas las herramientas de la CLI

gcloudygsutil. Consulte la documentación de Google Cloud para obtener más detalles. - El bucket de almacenamiento de GCP debe ser accesible para los clústeres de origen y destino.

Si utiliza el método de copia de instantáneas:

- Los clústeres de origen y destino deben estar en la misma región.

- Los clústeres de origen y destino deben tener la misma clase de almacenamiento.

- La clase de almacenamiento debe ser compatible con las instantáneas.

Procedimiento

Inicie sesión en GCP:

$ gcloud auth login

Establezca la variable

BUCKET:$ BUCKET=<bucket> 1- 1

- Especifica el nombre del bucket.

Cree el bucket de almacenamiento:

$ gsutil mb gs://$BUCKET/

Establezca la variable

PROJECT_IDpara su proyecto activo:$ PROJECT_ID=$(gcloud config get-value project)

Cree una cuenta de servicio:

$ gcloud iam service-accounts create velero \ --display-name "Velero service account"Enumere sus cuentas de servicio:

$ gcloud iam service-accounts list

Establezca la variable

SERVICE_ACCOUNT_EMAILpara que coincida con el valor de sucorreo electrónico:$ SERVICE_ACCOUNT_EMAIL=$(gcloud iam service-accounts list \ --filter="displayName:Velero service account" \ --format 'value(email)')Adjunte las políticas para conceder los permisos necesarios al usuario

velero:$ ROLE_PERMISSIONS=( compute.disks.get compute.disks.create compute.disks.createSnapshot compute.snapshots.get compute.snapshots.create compute.snapshots.useReadOnly compute.snapshots.delete compute.zones.get )Cree el rol personalizado

velero.server:$ gcloud iam roles create velero.server \ --project $PROJECT_ID \ --title "Velero Server" \ --permissions "$(IFS=","; echo "${ROLE_PERMISSIONS[*]}")"Añada la vinculación de la política IAM al proyecto:

$ gcloud projects add-iam-policy-binding $PROJECT_ID \ --member serviceAccount:$SERVICE_ACCOUNT_EMAIL \ --role projects/$PROJECT_ID/roles/velero.serverActualice la cuenta de servicio IAM:

$ gsutil iam ch serviceAccount:$SERVICE_ACCOUNT_EMAIL:objectAdmin gs://${BUCKET}Guarde las claves de la cuenta de servicio IAM en el archivo

credentials-veleroen el directorio actual:$ gcloud iam service-accounts keys create credentials-velero \ --iam-account $SERVICE_ACCOUNT_EMAILUtilice el archivo

credentials-veleropara añadir GCP como repositorio de replicación.

6.5.5. Configuración de Microsoft Azure

Configure un contenedor de almacenamiento de Microsoft Azure Blob como repositorio de replicación para Migration Toolkit for Containers (MTC).

Requisitos previos

- Debe tener instalada la CLI de Azure.

- El contenedor de almacenamiento de Azure Blob debe ser accesible para los clústeres de origen y destino.

Si utiliza el método de copia de instantáneas:

- Los clústeres de origen y destino deben estar en la misma región.

- Los clústeres de origen y destino deben tener la misma clase de almacenamiento.

- La clase de almacenamiento debe ser compatible con las instantáneas.

Procedimiento

Inicie sesión en Azure:

$ az login

Establezca la variable

AZURE_RESOURCE_GROUP:$ AZURE_RESOURCE_GROUP=Velero_Backups

Cree un grupo de recursos de Azure:

$ az group create -n $AZURE_RESOURCE_GROUP --location CentralUS 1- 1

- Especifique su ubicación.

Establezca la variable

AZURE_STORAGE_ACCOUNT_ID:$ AZURE_STORAGE_ACCOUNT_ID="velero$(uuidgen | cut -d '-' -f5 | tr '[A-Z]' '[a-z]')"

Cree una cuenta de almacenamiento de Azure:

$ az storage account create \ --name $AZURE_STORAGE_ACCOUNT_ID \ --resource-group $AZURE_BACKUP_RESOURCE_GROUP \ --sku Standard_GRS \ --encryption-services blob \ --https-only true \ --kind BlobStorage \ --access-tier HotEstablezca la variable

BLOB_CONTAINER:$ BLOB_CONTAINER=velero

Cree un contenedor de almacenamiento de Azure Blob:

$ az storage container create \ -n $BLOB_CONTAINER \ --public-access off \ --account-name $AZURE_STORAGE_ACCOUNT_ID

Cree un servicio principal y credenciales para

velero:$ AZURE_SUBSCRIPTION_ID=`az account list --query '[?isDefault].id' -o tsv` \ AZURE_TENANT_ID=`az account list --query '[?isDefault].tenantId' -o tsv` \ AZURE_CLIENT_SECRET=`az ad sp create-for-rbac --name "velero" \ --role "Contributor" --query 'password' -o tsv` \ AZURE_CLIENT_ID=`az ad sp list --display-name "velero" \ --query '[0].appId' -o tsv`

Guarde las credenciales de la entidad principal de servicio en el archivo

credentials-velero:$ cat << EOF > ./credentials-velero AZURE_SUBSCRIPTION_ID=${AZURE_SUBSCRIPTION_ID} AZURE_TENANT_ID=${AZURE_TENANT_ID} AZURE_CLIENT_ID=${AZURE_CLIENT_ID} AZURE_CLIENT_SECRET=${AZURE_CLIENT_SECRET} AZURE_RESOURCE_GROUP=${AZURE_RESOURCE_GROUP} AZURE_CLOUD_NAME=AzurePublicCloud EOFUtilice el archivo

credentials-veleropara añadir Azure como repositorio de replicación.

6.5.6. Recursos adicionales

6.6. Desinstalación de MTC y eliminación de recursos

Puede desinstalar Migration Toolkit for Containers (MTC) y eliminar sus recursos para limpiar el clúster.

Al borrar las CRD de velero se elimina Velero del clúster.

Requisitos previos

-

Debe iniciar la sesión como usuario con privilegios de

administrador de clúster.

Procedimiento

Elimine el recurso personalizado (CR)

MigrationControllerde todos los clústeres:$ oc delete migrationcontroller <migration_controller>

- Desinstale el operador de Migration Toolkit for Containers de OpenShift Container Platform 4 utilizando Operator Lifecycle Manager.

Elimine los recursos del clúster de todos los clústeres ejecutando los siguientes comandos:

Definiciones de recursos personalizados (CRD) de

migration:$ oc delete $(oc get crds -o name | grep 'migration.openshift.io')

CRD de

velero:$ oc delete $(oc get crds -o name | grep 'velero')

Roles del clúster de

migration:$ oc delete $(oc get clusterroles -o name | grep 'migration.openshift.io')

Roles del clúster de

migration-operator:$ oc delete clusterrole migration-operator

Roles del clúster de

velero:$ oc delete $(oc get clusterroles -o name | grep 'velero')

Vinculaciones de roles del clúster de

migration:$ oc delete $(oc get clusterrolebindings -o name | grep 'migration.openshift.io')

Vinculaciones de roles del clúster de

migration-operator:$ oc delete clusterrolebindings migration-operator

Vinculaciones de roles del clúster de

velero:$ oc delete $(oc get clusterrolebindings -o name | grep 'velero')

Capítulo 7. Instalación de Migration Toolkit for Containers en un entorno de red restringido

Puede instalar Migration Toolkit for Containers (MTC) en OpenShift Container Platform 3 y 4 en un entorno de red restringido realizando los siguientes procedimientos:

Cree un catálogo de operadores en espejo.

Este proceso crea un archivo

mapping.txtque contiene la asignación entre la imagenregistry.redhat.ioy su imagen de registro en espejo. El archivomapping.txtes necesario para instalar el operador en el clúster de origen.Instale el operador de Migration Toolkit for Containers en el clúster de destino de OpenShift Container Platform 4.10 mediante Operator Lifecycle Manager.

Por defecto, la consola web de MTC y el pod

Migration Controllerse ejecutan en el clúster de destino. Puede configurar el manifiesto de recursos personalizados deMigration Controllerpara que ejecute la consola web de MTC y el podMigration Controlleren el clúster de origen o en un clúster remoto.- Instale el operador de Migration Toolkit for Containers heredado en el clúster de origen de OpenShift Container Platform 3 desde la interfaz de la línea de comandos.

- Configure el almacenamiento de objetos para utilizarlo como repositorio de replicación.

Para desinstalar MTC, consulte Desinstalación de MTC y eliminación de recursos.

7.1. Directrices de compatibilidad

Debe instalar el operador de Migration Toolkit for Containers (MTC) compatible con su versión de OpenShift Container Platform.

Definiciones

- plataforma heredada

- OpenShift Container Platform 4.5 y anteriores.

- plataforma moderna

- OpenShift Container Platform 4.6 y posteriores.

- operador heredado

- El Operador MTC diseñado para plataformas heredadas.

- operador moderno

- El Operador MTC diseñado para plataformas modernas.

- grupo de control

- El clúster que ejecuta el controlador MTC y la GUI.

- grupo remoto

- Un clúster de origen o destino para una migración que ejecuta Velero. El clúster de control se comunica con los clústeres remotos a través de la API de Velero para impulsar las migraciones.

| OpenShift Container Platform 4.5 o anterior | OpenShift Container Platform 4.6 posterior | |

|---|---|---|

| Última versión del MTC | MTC 1.7.z

Operador legado 1.7: Instalar manualmente con el archivo Importante Este clúster no puede ser el de control. | MTC 1.7.z

Instalación con OLM, canal de |

| Versión estable de MTC | MTC 1.5

Operador heredado 1.5: Instalar manualmente con el archivo | MTC 1.6.z

Instalación con OLM, canal de |

Existen casos en los que las restricciones de red impiden que los clusters modernos se conecten a otros clusters que participan en la migración. Por ejemplo, al migrar de un clúster de OpenShift Container Platform 3.11 en las instalaciones a un clúster moderno de OpenShift Container Platform en la nube, donde el clúster moderno no puede conectarse al clúster de OpenShift Container Platform 3.11.

Con MTC 1.7, si uno de los clústeres remotos no puede comunicarse con el clúster de control debido a restricciones de red, utilice el comando crane tunnel-api.

Con la versión estable de MTC, aunque siempre se debe designar el clúster más moderno como clúster de control, en este caso concreto es posible designar el clúster heredado como clúster de control y empujar las cargas de trabajo al clúster remoto.

7.2. Instalación del operador de Migration Toolkit for Containers en OpenShift Container Platform 4.10

Instale el operador de Migration Toolkit for Containers en OpenShift Container Platform 4.10 con Operator Lifecycle Manager.

Requisitos previos

-

Debe iniciar la sesión como usuario con privilegios de

administrador de clústeren todos los clústeres. - Debe crear un catálogo de operadores a partir de una imagen en espejo en un registro local.

Procedimiento

- En la consola web de OpenShift Container Platform, haga clic en Operators (Operadores) → OperatorHub.

- Utilice el campo Filter by keyword (Filtrar por palabra clave) para encontrar el operador de Migration Toolkit for Containers.

- Seleccione el operador de Migration Toolkit for Containers y haga clic en Install (Instalar).

Haga clic en Install (Instalar).

En la página Installed Operators (Operadores instalados), el operador de Migration Toolkit for Containers aparece en el proyecto openshift-migration con el estado Succeeded (Correcto).

- Haga clic en el operador de Migration Toolkit for Containers.

- En Provided APIs (API proporcionadas), localice el mosaico Migration Controller (Controlador de migración) y haga clic en Create Instance (Crear instancia).

- Haga clic en Create (Crear).

- Haga clic en Workloads (Cargas de trabajo) → Pods para comprobar que los pods de MTC se están ejecutando.

7.3. Instalación del operador de Migration Toolkit for Containers heredado en OpenShift Container Platform 3

Puede instalar manualmente el operador de Migration Toolkit for Containers heredado en OpenShift Container Platform 3.

Requisitos previos

-

Debe iniciar la sesión como usuario con privilegios de

administrador de clústeren todos los clústeres. -

Debe tener acceso a

registry.redhat.io. -

Debe tener instalado

Podman. - Debe crear un secreto de flujo de imágenes y copiarlo en cada nodo del clúster.

-

Debe tener una estación de trabajo Linux con acceso a la red para poder descargar archivos de

registry.redhat.io. - Debe crear una imagen en espejo del catálogo de operadores.

- Debe instalar el operador de Migration Toolkit for Containers desde el catálogo de operadores en espejo en OpenShift Container Platform 4.10.

Procedimiento

Inicie sesión en

registry.redhat.iocon sus credenciales del Portal del cliente de Red Hat:$ sudo podman login registry.redhat.io

Descargue el archivo

operator.yml:$ sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.5.3):/operator.yml ./

Descargue el archivo

controller.yml:$ sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.5.3):/controller.yml ./

Obtenga la asignación de la imagen del operador ejecutando el siguiente comando:

$ grep openshift-migration-legacy-rhel8-operator ./mapping.txt | grep rhmtc

El archivo

mapping.txtse creó cuando se replicó el catálogo de operadores. El resultado muestra la asignación entre la imagenregistry.redhat.ioy su imagen de registro en espejo.Ejemplo de salida

registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator@sha256:468a6126f73b1ee12085ca53a312d1f96ef5a2ca03442bcb63724af5e2614e8a=<registry.apps.example.com>/rhmtc/openshift-migration-legacy-rhel8-operator

Actualice los valores de la

imagenpara los contenedoresansibleyoperatory el valorREGISTRYen el archivooperator.yml:containers: - name: ansible image: <registry.apps.example.com>/rhmtc/openshift-migration-legacy-rhel8-operator@sha256:<468a6126f73b1ee12085ca53a312d1f96ef5a2ca03442bcb63724af5e2614e8a> 1 ... - name: operator image: <registry.apps.example.com>/rhmtc/openshift-migration-legacy-rhel8-operator@sha256:<468a6126f73b1ee12085ca53a312d1f96ef5a2ca03442bcb63724af5e2614e8a> 2 ... env: - name: REGISTRY value: <registry.apps.example.com> 3- Inicie sesión en su clúster de OpenShift Container Platform 3.

Cree el objeto del operador de Migration Toolkit for Containers:

$ oc create -f operator.yml

Ejemplo de salida

namespace/openshift-migration created rolebinding.rbac.authorization.k8s.io/system:deployers created serviceaccount/migration-operator created customresourcedefinition.apiextensions.k8s.io/migrationcontrollers.migration.openshift.io created role.rbac.authorization.k8s.io/migration-operator created rolebinding.rbac.authorization.k8s.io/migration-operator created clusterrolebinding.rbac.authorization.k8s.io/migration-operator created deployment.apps/migration-operator created Error from server (AlreadyExists): error when creating "./operator.yml": rolebindings.rbac.authorization.k8s.io "system:image-builders" already exists 1 Error from server (AlreadyExists): error when creating "./operator.yml": rolebindings.rbac.authorization.k8s.io "system:image-pullers" already exists- 1

- Puede ignorar los mensajes de

error del servidor (AlreadyExists). Son causados por el operador de Migration Toolkit for Containers que crea recursos para versiones anteriores de OpenShift Container Platform 3 que se proporcionan en versiones posteriores.

Cree el objeto

MigrationController:$ oc create -f controller.yml

Compruebe que los pods de MTC estén en funcionamiento:

$ oc get pods -n openshift-migration

7.4. Configuración de los proxies

Para OpenShift Container Platform 4.1 y versiones anteriores, debe configurar los proxies en el manifiesto de recursos personalizados (CR) de MigrationController después de instalar el operador de Migration Toolkit for Containers dado que estas versiones no admiten un objeto proxy para todo el clúster.

Para OpenShift Container Platform 4.2 a 4.10, Migration Toolkit for Containers (MTC) hereda la configuración del proxy de todo el clúster. Puede cambiar los parámetros del proxy si desea anular la configuración del proxy en todo el clúster.

Debe configurar los proxies para que permitan el protocolo SPDY y reenvíen el encabezado HTTP de actualización al servidor de la API. De lo contrario, se muestra un error de solicitud de actualización requerida. El CR MigrationController utiliza SPDY para ejecutar comandos dentro de los pods remotos. El encabezado HTTP Upgrade es necesario para abrir una conexión websocket con el servidor de la API.

Migración directa de volúmenes

Si realiza una migración directa de volúmenes (DVM) desde un clúster de origen detrás de un proxy, debe configurar el proxy Stunnel. Stunnel crea un túnel transparente entre los clústeres de origen y destino para la conexión TCP sin cambiar los certificados.

La DVM solo admite un proxy. El clúster de origen no puede acceder a la ruta del clúster de destino si éste también está detrás de un proxy.

Requisitos previos

-

Debe iniciar la sesión como usuario con privilegios de

administrador de clústeren todos los clústeres.

Procedimiento

Obtenga el manifiesto del CR

MigrationController:$ oc get migrationcontroller <migration_controller> -n openshift-migration

Actualice los parámetros del proxy:

apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: <migration_controller> namespace: openshift-migration ... spec: stunnel_tcp_proxy: http://<username>:<password>@<ip>:<port> 1 httpProxy: http://<username>:<password>@<ip>:<port> 2 httpsProxy: http://<username>:<password>@<ip>:<port> 3 noProxy: example.com 4

- 1

- URL del proxy Stunnel para la migración directa de volúmenes.

- 2

- URL del proxy para crear conexiones HTTP fuera del clúster. El esquema de la URL debe ser

http. - 3

- URL del proxy para crear conexiones HTTPS fuera del clúster. Si no se especifica, se utiliza

httpProxypara las conexiones HTTP y HTTPS. - 4

- Lista separada por comas de nombres de dominio de destino, dominios, direcciones IP u otros CIDR de red para excluir el proxy.

Introduzca un dominio con

.para que coincida solo con los subdominios. Por ejemplo,.y.comcoincide conx.y.com, pero no cony.com. Utilice*para evitar el proxy en todos los destinos. Si escala a los trabajadores que no están incluidos en la red definida por el camponetworking.machineNetwork[].cidrde la configuración de instalación, debe añadirlos a esta lista para evitar problemas de conexión.Este campo se ignora si no se establecen los campos

httpProxyyhttpsProxy.-

Guarde el manifiesto como

migration-controller.yaml. Aplique el manifiesto actualizado:

$ oc replace -f migration-controller.yaml -n openshift-migration

Para obtener más información, consulte Configuración del proxy para todo el clúster.

7.5. Configuración de un repositorio de replicación

Multicloud Object Gateway es la única opción admitida para un entorno de red restringido.

MTC admite los métodos de copia de datos de instantáneas y sistemas de archivos para migrar los datos del clúster de origen al clúster de destino. Puede seleccionar un método que se adapte a su entorno y que sea compatible con su proveedor de almacenamiento.

7.5.1. Requisitos previos

- Todos los clústeres deben tener un acceso de red ininterrumpido al repositorio de replicación.

- Si utiliza un servidor proxy con un repositorio de replicación alojado internamente, debe asegurarse de que el proxy permita el acceso al repositorio de replicación.

7.5.2. Recuperación de las credenciales de Multicloud Object Gateway

Debe recuperar las credenciales de Multicloud Object Gateway (MCG) para crear un recurso personalizado (CR) secreto para OpenShift API for Data Protection (OADP).

MCG es un componente de OpenShift Container Storage.

Requisitos previos

- Debe implementar OpenShift Container Storage utilizando la guía de implementación de OpenShift Container Storage adecuada.

Procedimiento

-

Obtenga el terminal S3,

AWS_ACCESS_KEY_IDyAWS_SECRET_ACCESS_KEYejecutando el comandodescribeen el recurso personalizadoNooBaa.

7.5.3. Recursos adicionales

7.6. Desinstalación de MTC y eliminación de recursos

Puede desinstalar Migration Toolkit for Containers (MTC) y eliminar sus recursos para limpiar el clúster.

Al borrar las CRD de velero se elimina Velero del clúster.

Requisitos previos

-

Debe iniciar la sesión como usuario con privilegios de

administrador de clúster.

Procedimiento

Elimine el recurso personalizado (CR)

MigrationControllerde todos los clústeres:$ oc delete migrationcontroller <migration_controller>

- Desinstale el operador de Migration Toolkit for Containers de OpenShift Container Platform 4 utilizando Operator Lifecycle Manager.

Elimine los recursos del clúster de todos los clústeres ejecutando los siguientes comandos:

Definiciones de recursos personalizados (CRD) de

migration:$ oc delete $(oc get crds -o name | grep 'migration.openshift.io')

CRD de

velero:$ oc delete $(oc get crds -o name | grep 'velero')

Roles del clúster de

migration:$ oc delete $(oc get clusterroles -o name | grep 'migration.openshift.io')

Roles del clúster de

migration-operator:$ oc delete clusterrole migration-operator

Roles del clúster de

velero:$ oc delete $(oc get clusterroles -o name | grep 'velero')

Vinculaciones de roles del clúster de

migration:$ oc delete $(oc get clusterrolebindings -o name | grep 'migration.openshift.io')

Vinculaciones de roles del clúster de

migration-operator:$ oc delete clusterrolebindings migration-operator

Vinculaciones de roles del clúster de

velero:$ oc delete $(oc get clusterrolebindings -o name | grep 'velero')

Capítulo 8. Actualización de Migration Toolkit for Containers

Puede actualizar Migration Toolkit for Containers (MTC) en OpenShift Container Platform 4.10 mediante Operator Lifecycle Manager.

Puede actualizar MTC en OpenShift Container Platform 3 reinstalando el antiguo operador de Migration Toolkit for Containers.

Si actualiza desde la versión 1.3 de MTC, debe realizar un procedimiento adicional para actualizar el recurso personalizado (CR) de MigPlan.

8.1. Actualización de Migration Toolkit for Containers en OpenShift Container Platform 4.10

Puede actualizar Migration Toolkit for Containers (MTC) en OpenShift Container Platform 4.10 mediante Operator Lifecycle Manager.

Requisitos previos

-

Debe iniciar la sesión como usuario con privilegios de

administrador de clúster.

Procedimiento

En la consola de OpenShift Container Platform, navegue hasta Operators (Operadores) → Installed Operators (Operadores instalados).

Los operadores que tienen una actualización pendiente muestran el estado Upgrade available (Actualización disponible).

- Haga clic en el operador de Migration Toolkit for Containers.

- Haga clic en la pestaña Subscription (Suscripción). Cualquier actualización que requiera aprobación se muestra junto a Upgrade Status (Estado de la actualización). Por ejemplo, puede mostrar 1 requires approval (1 requiere aprobación).

- Haga clic en 1 requires approval (1 requiere aprobación) y, luego, en Preview Install Plan (Vista previa del plan de instalación).

- Revise los recursos que aparecen como disponibles para la actualización y haga clic en Approve (Aprobar).

- Vuelva a navegar a la página Operators → Installed Operators (Operadores → Operadores instalados) para supervisar el progreso de la actualización. Una vez completado, el estado cambia a Succeeded (Correcto) y Up to date (Actualizado).

- Haga clic en el operador de Migration Toolkit for Containers.

- En Provided APIs (API proporcionadas), localice el mosaico Migration Controller (Controlador de migración) y haga clic en Create Instance (Crear instancia).

- Haga clic en Workloads (Cargas de trabajo) → Pods para comprobar que los pods de MTC se están ejecutando.

8.2. Actualización de Migration Toolkit for Containers en OpenShift Container Platform 3

Puede actualizar Migration Toolkit for Containers (MTC) en OpenShift Container Platform 3 instalando manualmente el operador de Migration Toolkit for Containers heredado.

Requisitos previos

-

Debe iniciar la sesión como usuario con privilegios de

administrador de clúster. -

Debe tener acceso a

registry.redhat.io. -

Debe tener instalado

Podman.

Procedimiento

Inicie sesión en

registry.redhat.iocon sus credenciales del Portal del cliente de Red Hat:$ sudo podman login registry.redhat.io

Descargue el archivo

operator.yml:$ sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.5.3):/operator.yml ./

Sustituya el operador de Migration Toolkit for Containers:

$ oc replace --force -f operator.yml

Escale la implementación de

migration-operatora0para detenerla:$ oc scale -n openshift-migration --replicas=0 deployment/migration-operator

Escale la implementación de

migration-operatora1para iniciarla y aplicar los cambios:$ oc scale -n openshift-migration --replicas=1 deployment/migration-operator

Verifique que

migration-operatorse haya actualizado:$ oc -o yaml -n openshift-migration get deployment/migration-operator | grep image: | awk -F ":" '{ print $NF }'Descargue el archivo

controller.yml:$ sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.5.3):/controller.yml ./

Cree el objeto

migration-controller:$ oc create -f controller.yml

Si ha añadido previamente el clúster de OpenShift Container Platform 3 a la consola web de MTC, debe actualizar el token de la cuenta de servicio en la consola web porque el proceso de actualización elimina y restaura el espacio de nombres

openshift-migration:Obtenga el token de la cuenta de servicio:

$ oc sa get-token migration-controller -n openshift-migration

- En la consola web de MTC, haga clic en Clusters (Clústeres).

-

Haga clic en el menú Options (Opciones)

junto al clúster y seleccione Edit (Editar).

junto al clúster y seleccione Edit (Editar).

- Introduzca el nuevo token de cuenta de servicio en el campo Service account token (Token de cuenta de servicio).

- Haga clic en Update cluster (Actualizar clúster) y, luego, en Close (Cerrar).

Compruebe que los pods de MTC estén en funcionamiento:

$ oc get pods -n openshift-migration

8.3. Actualización de MTC 1.3 a 1.7

Si está actualizando la versión 1.3.x de Migration Toolkit for Containers (MTC) a la 1.7, debe actualizar el manifiesto de recursos personalizados (CR) de MigPlan en el clúster en el que se ejecuta el pod de MigrationController.