Authentification et autorisation

Configuration de l'authentification des utilisateurs et des contrôles d'accès pour les utilisateurs et les services

Résumé

Chapitre 1. Aperçu de l'authentification et de l'autorisation

1.1. Glossaire des termes courants pour l'authentification et l'autorisation de OpenShift Container Platform

Ce glossaire définit les termes communs utilisés dans l'authentification et l'autorisation de OpenShift Container Platform.

- l'authentification

- Une authentification détermine l'accès à un cluster OpenShift Container Platform et garantit que seuls les utilisateurs authentifiés accèdent au cluster OpenShift Container Platform.

- autorisation

- L'autorisation détermine si l'utilisateur identifié a le droit d'effectuer l'action demandée.

- jeton au porteur

-

Le jeton du porteur est utilisé pour s'authentifier auprès de l'API avec l'en-tête

Authorization: Bearer <token>. - Opérateur de certificats dans le nuage

- Le Cloud Credential Operator (CCO) gère les informations d'identification des fournisseurs de cloud sous forme de définitions de ressources personnalisées (CRD).

- carte de configuration

-

Une carte de configuration permet d'injecter des données de configuration dans les pods. Vous pouvez référencer les données stockées dans une carte de configuration dans un volume de type

ConfigMap. Les applications fonctionnant dans un pod peuvent utiliser ces données. - conteneurs

- Images légères et exécutables composées de logiciels et de toutes leurs dépendances. Comme les conteneurs virtualisent le système d'exploitation, vous pouvez les exécuter dans un centre de données, un nuage public ou privé, ou votre hôte local.

- Ressource personnalisée (CR)

- Un CR est une extension de l'API Kubernetes.

- groupe

- Un groupe est un ensemble d'utilisateurs. Un groupe est utile pour accorder des autorisations à plusieurs utilisateurs en même temps.

- HTPasswd

- HTPasswd met à jour les fichiers qui stockent les noms d'utilisateur et les mots de passe pour l'authentification des utilisateurs HTTP.

- Keystone

- Keystone est un projet de Red Hat OpenStack Platform (RHOSP) qui fournit des services d'identité, de jeton, de catalogue et de politique.

- Protocole d'accès à l'annuaire léger (LDAP)

- LDAP est un protocole qui permet d'interroger les informations sur les utilisateurs.

- mode manuel

- En mode manuel, c'est un utilisateur qui gère les informations d'identification dans le nuage à la place de l'opérateur d'informations d'identification dans le nuage (Cloud Credential Operator, CCO).

- mode menthe

- Le mode Mint est le paramètre par défaut et la meilleure pratique recommandée pour le Cloud Credential Operator (CCO) sur les plates-formes pour lesquelles il est pris en charge. Dans ce mode, le CCO utilise le justificatif d'identité cloud de niveau administrateur fourni pour créer de nouveaux justificatifs d'identité pour les composants du cluster avec uniquement les autorisations spécifiques requises.

- espace de noms

- Un espace de noms isole des ressources système spécifiques qui sont visibles par tous les processus. À l'intérieur d'un espace de noms, seuls les processus membres de cet espace peuvent voir ces ressources.

- nœud

- Un nœud est une machine de travail dans le cluster OpenShift Container Platform. Un nœud est soit une machine virtuelle (VM), soit une machine physique.

- Client OAuth

- Le client OAuth est utilisé pour obtenir un jeton de porteur.

- Serveur OAuth

- Le plan de contrôle d'OpenShift Container Platform comprend un serveur OAuth intégré qui détermine l'identité de l'utilisateur à partir du fournisseur d'identité configuré et crée un jeton d'accès.

- OpenID Connect

- OpenID Connect est un protocole qui permet d'authentifier les utilisateurs afin d'utiliser l'authentification unique (SSO) pour accéder aux sites qui utilisent les fournisseurs OpenID.

- mode passthrough

- En mode passthrough, le Cloud Credential Operator (CCO) transmet le justificatif d'identité cloud fourni aux composants qui demandent des justificatifs d'identité cloud.

- nacelle

- Un pod est la plus petite unité logique de Kubernetes. Un pod est composé d'un ou plusieurs conteneurs à exécuter dans un nœud de travailleur.

- utilisateurs réguliers

- Utilisateurs créés automatiquement dans le cluster lors de la première connexion ou via l'API.

- en-tête de la demande

- Un en-tête de requête est un en-tête HTTP utilisé pour fournir des informations sur le contexte de la requête HTTP, afin que le serveur puisse suivre la réponse à la requête.

- le contrôle d'accès basé sur les rôles (RBAC)

- Un contrôle de sécurité clé pour s'assurer que les utilisateurs et les charges de travail des clusters n'ont accès qu'aux ressources nécessaires à l'exécution de leurs rôles.

- comptes de service

- Les comptes de service sont utilisés par les composants ou les applications du cluster.

- les utilisateurs du système

- Utilisateurs créés automatiquement lors de l'installation du cluster.

- utilisateurs

- L'utilisateur est une entité qui peut faire des demandes à l'API.

1.2. À propos de l'authentification dans OpenShift Container Platform

Pour contrôler l'accès à un cluster OpenShift Container Platform, un administrateur de cluster peut configurer l'authentification des utilisateurs et s'assurer que seuls les utilisateurs approuvés accèdent au cluster.

Pour interagir avec un cluster OpenShift Container Platform, les utilisateurs doivent d'abord s'authentifier auprès de l'API OpenShift Container Platform d'une manière ou d'une autre. Vous pouvez vous authentifier en fournissant un jeton d'accès OAuth ou un certificat client X.509 dans vos demandes à l'API OpenShift Container Platform.

Si vous ne présentez pas de jeton d'accès ou de certificat valide, votre demande n'est pas authentifiée et vous recevez une erreur HTTP 401.

Un administrateur peut configurer l'authentification en effectuant les tâches suivantes :

- Configuration d'un fournisseur d'identité : Vous pouvez définir n'importe quel fournisseur d'identité pris en charge dans OpenShift Container Platform et l'ajouter à votre cluster.

Configuration du serveur OAuth interne: Le plan de contrôle d'OpenShift Container Platform comprend un serveur OAuth intégré qui détermine l'identité de l'utilisateur à partir du fournisseur d'identité configuré et crée un jeton d'accès. Vous pouvez configurer la durée du jeton et le délai d'inactivité, et personnaliser l'URL du serveur OAuth interne.

NoteLes utilisateurs peuvent consulter et gérer les jetons OAuth dont ils sont propriétaires.

Enregistrement d'un client OAuth : OpenShift Container Platform inclut plusieurs clients OAuth par défaut. Vous pouvez enregistrer et configurer des clients OAuth supplémentaires.

NoteLorsque les utilisateurs envoient une demande de jeton OAuth, ils doivent spécifier un client OAuth par défaut ou personnalisé qui reçoit et utilise le jeton.

- Gestion des informations d'identification du fournisseur de cloud à l'aide de l'opérateur d'informations d'identification du cloud: Les composants du cluster utilisent les informations d'identification du fournisseur de cloud pour obtenir les autorisations nécessaires à l'exécution des tâches liées au cluster.

- Usurpation d'identité d'un utilisateur administrateur système : Vous pouvez accorder des droits d'administrateur de cluster à un utilisateur en vous faisant passer pour un utilisateur administrateur système.

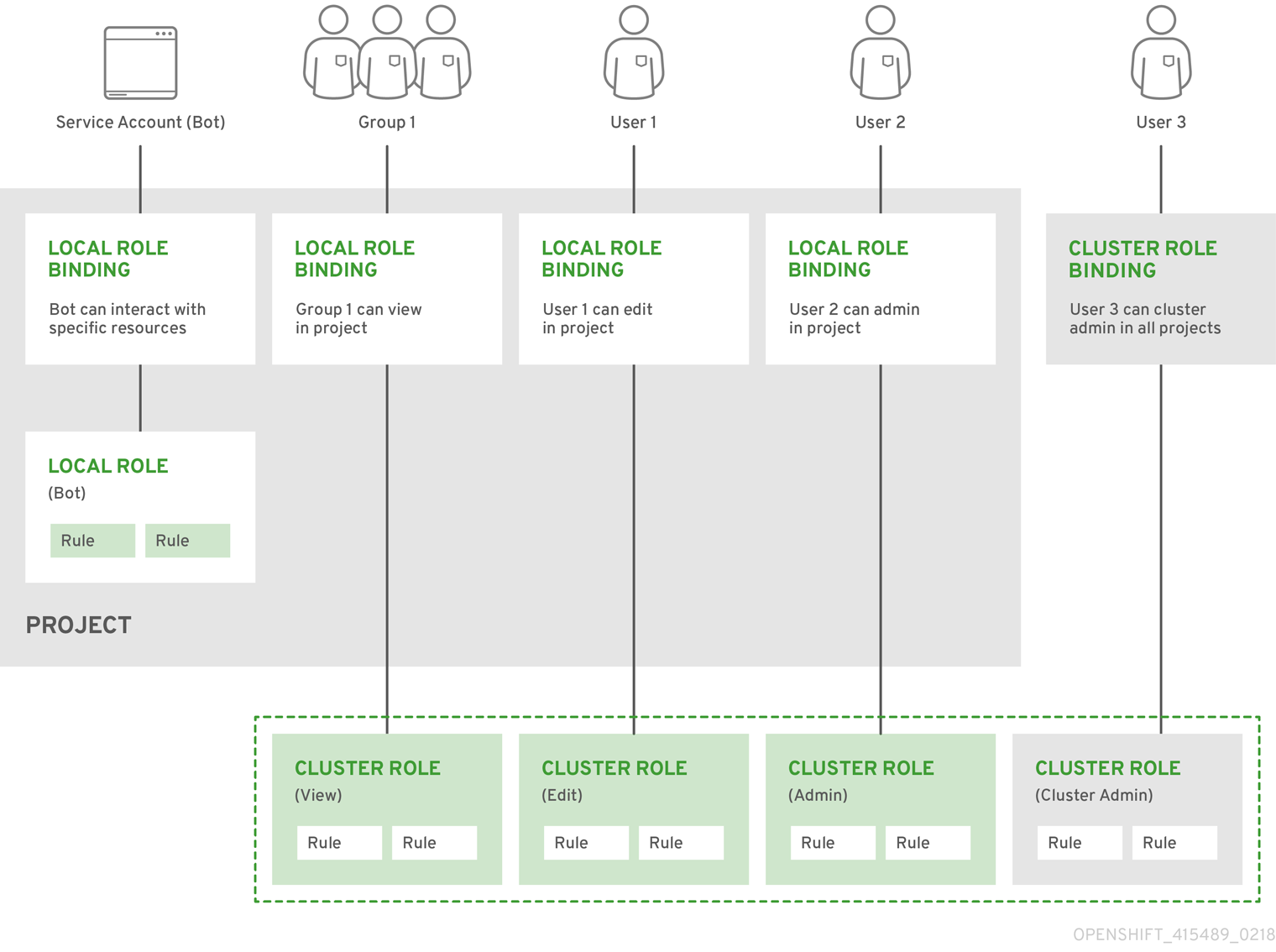

1.3. À propos de l'autorisation dans OpenShift Container Platform

L'autorisation consiste à déterminer si l'utilisateur identifié a le droit d'effectuer l'action demandée.

Les administrateurs peuvent définir les autorisations et les attribuer aux utilisateurs à l'aide des objets RBAC, tels que les règles, les rôles et les liaisons. Pour comprendre comment fonctionne l'autorisation dans OpenShift Container Platform, voir Évaluation de l'autorisation.

Vous pouvez également contrôler l'accès à un cluster OpenShift Container Platform par le biais de projets et d'espaces de noms.

Outre le contrôle de l'accès des utilisateurs à un cluster, vous pouvez également contrôler les actions qu'un pod peut effectuer et les ressources auxquelles il peut accéder à l'aide de contraintes de contexte de sécurité (SCC).

Vous pouvez gérer l'autorisation pour OpenShift Container Platform en effectuant les tâches suivantes :

- Visualisation des rôles et des liens locaux et de cluster.

- Créer un rôle local et l'attribuer à un utilisateur ou à un groupe.

- Créer un rôle de cluster et l'attribuer à un utilisateur ou à un groupe : OpenShift Container Platform inclut un ensemble de rôles de cluster par défaut. Vous pouvez créer des rôles de cluster supplémentaires et les ajouter à un utilisateur ou à un groupe.

Création d'un utilisateur cluster-admin : Par défaut, votre cluster n'a qu'un seul administrateur de cluster appelé

kubeadmin. Vous pouvez créer un autre administrateur de cluster. Avant de créer un administrateur de cluster, assurez-vous que vous avez configuré un fournisseur d'identité.NoteAprès avoir créé l'utilisateur administrateur du cluster, supprimez l'utilisateur kubeadmin existant afin d'améliorer la sécurité du cluster.

- Création de comptes de service : Les comptes de service constituent un moyen souple de contrôler l'accès à l'API sans partager les informations d'identification d'un utilisateur normal. Un utilisateur peut créer et utiliser un compte de service dans des applications et également en tant que client OAuth.

- Jetons de portée: Un jeton de portée est un jeton qui identifie un utilisateur spécifique qui ne peut effectuer que des opérations spécifiques. Vous pouvez créer des jetons de portée pour déléguer certaines de vos autorisations à un autre utilisateur ou à un compte de service.

- Synchronisation des groupes LDAP : Vous pouvez gérer les groupes d'utilisateurs en un seul endroit en synchronisant les groupes stockés dans un serveur LDAP avec les groupes d'utilisateurs d'OpenShift Container Platform.

Chapitre 2. Comprendre l'authentification

Pour que les utilisateurs puissent interagir avec OpenShift Container Platform, ils doivent d'abord s'authentifier auprès du cluster. La couche d'authentification identifie l'utilisateur associé aux demandes de l'API OpenShift Container Platform. La couche d'autorisation utilise ensuite des informations sur l'utilisateur demandeur pour déterminer si la demande est autorisée.

En tant qu'administrateur, vous pouvez configurer l'authentification pour OpenShift Container Platform.

2.1. Utilisateurs

Un user dans OpenShift Container Platform est une entité qui peut faire des requêtes à l'API OpenShift Container Platform. Un objet User dans OpenShift Container Platform représente un acteur à qui l'on peut accorder des permissions dans le système en lui ajoutant des rôles ou des groupes. Typiquement, cela représente le compte d'un développeur ou d'un administrateur qui interagit avec OpenShift Container Platform.

Plusieurs types d'utilisateurs peuvent exister :

| Type d'utilisateur | Description |

|---|---|

|

|

C'est ainsi que sont représentés la plupart des utilisateurs interactifs d'OpenShift Container Platform. Les utilisateurs réguliers sont créés automatiquement dans le système lors de la première connexion ou peuvent être créés via l'API. Les utilisateurs réguliers sont représentés par l'objet |

|

|

Nombre d'entre eux sont créés automatiquement lors de la définition de l'infrastructure, principalement dans le but de permettre à l'infrastructure d'interagir avec l'API en toute sécurité. Il s'agit notamment d'un administrateur de cluster (qui a accès à tout), d'un utilisateur par nœud, d'utilisateurs pour les routeurs et les registres, et de divers autres. Enfin, il existe un utilisateur système |

|

|

Il s'agit d'utilisateurs spéciaux du système associés à des projets ; certains sont créés automatiquement lors de la création du projet, tandis que les administrateurs de projet peuvent en créer d'autres afin de définir l'accès au contenu de chaque projet. Les comptes de service sont représentés par l'objet |

Chaque utilisateur doit s'authentifier d'une manière ou d'une autre pour accéder à OpenShift Container Platform. Les demandes d'API sans authentification ou avec une authentification non valide sont authentifiées comme des demandes par l'utilisateur du système anonymous. Après l'authentification, la politique détermine ce que l'utilisateur est autorisé à faire.

2.2. Groupes

Un utilisateur peut être affecté à un ou plusieurs groups, chacun d'entre eux représentant un certain ensemble d'utilisateurs. Les groupes sont utiles pour gérer les politiques d'autorisation afin d'accorder des permissions à plusieurs utilisateurs à la fois, par exemple en autorisant l'accès à des objets au sein d'un projet, plutôt qu'en les accordant à des utilisateurs individuels.

En plus des groupes explicitement définis, il existe également des groupes système, ou virtual groups, qui sont automatiquement provisionnés par le cluster.

Les groupes virtuels par défaut suivants sont les plus importants :

| Groupe virtuel | Description |

|---|---|

|

| Automatiquement associé à tous les utilisateurs authentifiés. |

|

| Automatiquement associé à tous les utilisateurs authentifiés avec un jeton d'accès OAuth. |

|

| Automatiquement associé à tous les utilisateurs non authentifiés. |

2.3. Authentification de l'API

Les requêtes adressées à l'API OpenShift Container Platform sont authentifiées à l'aide des méthodes suivantes :

- Jetons d'accès OAuth

-

Obtenu à partir du serveur OAuth de OpenShift Container Platform à l'aide des paramètres

<namespace_route>/oauth/authorizeet<namespace_route>/oauth/token. -

Envoyé en tant qu'en-tête

Authorization: Bearer…. -

Envoyé en tant qu'en-tête du sous-protocole websocket sous la forme

base64url.bearer.authorization.k8s.io.<base64url-encoded-token>pour les requêtes websocket.

-

Obtenu à partir du serveur OAuth de OpenShift Container Platform à l'aide des paramètres

- Certificats clients X.509

- Nécessite une connexion HTTPS au serveur de l'API.

- Vérifié par le serveur API par rapport à un ensemble d'autorités de certification de confiance.

- Le serveur API crée et distribue des certificats aux contrôleurs pour qu'ils s'authentifient.

Toute demande comportant un jeton d'accès ou un certificat non valide est rejetée par la couche d'authentification avec une erreur 401.

Si aucun jeton d'accès ou certificat n'est présenté, la couche d'authentification attribue l'utilisateur virtuel system:anonymous et le groupe virtuel system:unauthenticated à la demande. Cela permet à la couche d'autorisation de déterminer quelles demandes, le cas échéant, un utilisateur anonyme est autorisé à faire.

2.3.1. Serveur OAuth de OpenShift Container Platform

Le master OpenShift Container Platform comprend un serveur OAuth intégré. Les utilisateurs obtiennent des jetons d'accès OAuth pour s'authentifier auprès de l'API.

Lorsqu'une personne demande un nouveau jeton OAuth, le serveur OAuth utilise le fournisseur d'identité configuré pour déterminer l'identité de la personne qui fait la demande.

Il détermine ensuite à quel utilisateur correspond cette identité, crée un jeton d'accès pour cet utilisateur et renvoie le jeton pour utilisation.

2.3.1.1. Demandes de jetons OAuth

Chaque demande de jeton OAuth doit spécifier le client OAuth qui recevra et utilisera le jeton. Les clients OAuth suivants sont automatiquement créés lors du démarrage de l'API OpenShift Container Platform :

| Client OAuth | Utilisation |

|---|---|

|

|

Demande des jetons à |

|

|

Demande de jetons avec un user-agent qui peut gérer les défis |

<namespace_route>fait référence à la route de l'espace de noms. On le trouve en exécutant la commande suivante :oc get route oauth-openshift -n openshift-authentication -o json | jq .spec.host

$ oc get route oauth-openshift -n openshift-authentication -o json | jq .spec.hostCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Toutes les demandes de jetons OAuth impliquent une requête à <namespace_route>/oauth/authorize. La plupart des intégrations d'authentification placent un proxy d'authentification devant ce point de terminaison, ou configurent OpenShift Container Platform pour valider les informations d'identification par rapport à un fournisseur d'identité de soutien. Les demandes adressées à <namespace_route>/oauth/authorize peuvent provenir d'agents utilisateurs qui ne peuvent pas afficher de pages de connexion interactives, telles que la CLI. Par conséquent, OpenShift Container Platform prend en charge l'authentification à l'aide d'un défi WWW-Authenticate en plus des flux de connexion interactifs.

Si un proxy d'authentification est placé devant le point de terminaison <namespace_route>/oauth/authorize, il envoie aux agents utilisateurs non authentifiés, qui ne sont pas des navigateurs, des défis WWW-Authenticate au lieu d'afficher une page de connexion interactive ou de rediriger vers un flux de connexion interactif.

Pour éviter les attaques de type cross-site request forgery (CSRF) contre les clients des navigateurs, n'envoyez des défis d'authentification de base que si un en-tête X-CSRF-Token figure sur la demande. Les clients qui s'attendent à recevoir des défis Basic WWW-Authenticate doivent attribuer à cet en-tête une valeur non vide.

Si le proxy d'authentification ne prend pas en charge les défis WWW-Authenticate ou si OpenShift Container Platform est configuré pour utiliser un fournisseur d'identité qui ne prend pas en charge les défis WWW-Authenticate, vous devez utiliser un navigateur pour obtenir manuellement un jeton à partir de <namespace_route>/oauth/token/request.

2.3.1.2. L'usurpation d'identité de l'API

Vous pouvez configurer une requête à l'API OpenShift Container Platform pour qu'elle agisse comme si elle provenait d'un autre utilisateur. Pour plus d'informations, voir User impersonation dans la documentation Kubernetes.

2.3.1.3. Mesures d'authentification pour Prometheus

OpenShift Container Platform capture les métriques système Prometheus suivantes lors des tentatives d'authentification :

-

openshift_auth_basic_password_countcompte le nombre de tentatives de saisie du nom d'utilisateur et du mot de passe suroc login. -

openshift_auth_basic_password_count_resultcompte le nombre de tentatives d'utilisation du nom d'utilisateur et du mot de passeoc loginpar résultat,successouerror. -

openshift_auth_form_password_countcompte le nombre de tentatives de connexion à la console web. -

openshift_auth_form_password_count_resultcompte le nombre de tentatives de connexion à la console web par résultat,successouerror. -

openshift_auth_password_totalcompte le nombre total de tentatives de connexion àoc loginet à la console web.

Chapitre 3. Configuration du serveur OAuth interne

3.1. Serveur OAuth de OpenShift Container Platform

Le master OpenShift Container Platform comprend un serveur OAuth intégré. Les utilisateurs obtiennent des jetons d'accès OAuth pour s'authentifier auprès de l'API.

Lorsqu'une personne demande un nouveau jeton OAuth, le serveur OAuth utilise le fournisseur d'identité configuré pour déterminer l'identité de la personne qui fait la demande.

Il détermine ensuite à quel utilisateur correspond cette identité, crée un jeton d'accès pour cet utilisateur et renvoie le jeton pour utilisation.

3.2. Flux de demandes de jetons OAuth et réponses

Le serveur OAuth prend en charge le code d' autorisation standard et les flux d'autorisation OAuth implicites.

Lors d'une demande de jeton OAuth utilisant le flux d'octroi implicite (response_type=token) avec un identifiant client configuré pour demander WWW-Authenticate challenges (comme openshift-challenging-client), voici les réponses possibles du serveur à partir de /oauth/authorize, et la façon dont elles doivent être traitées :

| Statut | Contenu | Réponse du client |

|---|---|---|

| 302 |

|

Utilisez la valeur |

| 302 |

|

Échouer, en faisant éventuellement apparaître à l'utilisateur les valeurs de la requête |

| 302 |

Autre en-tête | Suivez la redirection et traitez le résultat à l'aide de ces règles. |

| 401 |

|

Répondre au défi si le type est reconnu (par exemple |

| 401 |

| Aucune authentification par défi n'est possible. Échec et affichage du corps de la réponse (qui peut contenir des liens ou des détails sur d'autres méthodes pour obtenir un jeton OAuth). |

| Autres | Autres | Échec, éventuellement en faisant apparaître le corps de la réponse à l'utilisateur. |

3.3. Options pour le serveur OAuth interne

Plusieurs options de configuration sont disponibles pour le serveur OAuth interne.

3.3.1. Options de durée du jeton OAuth

Le serveur OAuth interne génère deux types de jetons :

| Jeton | Description |

|---|---|

| Jetons d'accès | Jetons à durée de vie plus longue qui permettent d'accéder à l'API. |

| Autoriser les codes | Jetons de courte durée dont la seule utilité est d'être échangés contre un jeton d'accès. |

Vous pouvez configurer la durée par défaut pour les deux types de jetons. Si nécessaire, vous pouvez remplacer la durée du jeton d'accès en utilisant une définition d'objet OAuthClient.

3.3.2. Options d'octroi d'OAuth

Lorsque le serveur OAuth reçoit des demandes de jetons pour un client auquel l'utilisateur n'a pas accordé d'autorisation au préalable, l'action du serveur OAuth dépend de la stratégie d'octroi du client OAuth.

Le client OAuth qui demande le jeton doit fournir sa propre stratégie d'octroi.

Vous pouvez appliquer les méthodes par défaut suivantes :

| Option d'attribution | Description |

|---|---|

|

| Approuver automatiquement la subvention et réessayer la demande. |

|

| Inviter l'utilisateur à approuver ou à refuser la subvention. |

3.4. Configuration de la durée du jeton du serveur OAuth interne

Vous pouvez configurer des options par défaut pour la durée du jeton du serveur OAuth interne.

Par défaut, les jetons ne sont valables que 24 heures. Les sessions existantes expirent à l'issue de cette période.

Si la durée par défaut est insuffisante, elle peut être modifiée en suivant la procédure suivante.

Procédure

Créez un fichier de configuration contenant les options relatives à la durée du jeton. Le fichier suivant fixe cette durée à 48 heures, soit le double de la valeur par défaut.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Définissez

accessTokenMaxAgeSecondspour contrôler la durée de vie des jetons d'accès. La durée de vie par défaut est de 24 heures, soit 86400 secondes. Cet attribut ne peut pas être négatif. S'il est défini à zéro, la durée de vie par défaut est utilisée.

Appliquer le nouveau fichier de configuration :

NoteComme vous mettez à jour le serveur OAuth existant, vous devez utiliser la commande

oc applypour appliquer la modification.oc apply -f </path/to/file.yaml>

$ oc apply -f </path/to/file.yaml>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Confirmez que les modifications sont effectives :

oc describe oauth.config.openshift.io/cluster

$ oc describe oauth.config.openshift.io/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

... Spec: Token Config: Access Token Max Age Seconds: 172800 ...... Spec: Token Config: Access Token Max Age Seconds: 172800 ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5. Configuration du délai d'inactivité du jeton pour le serveur OAuth interne

Vous pouvez configurer les jetons OAuth pour qu'ils expirent après une période d'inactivité donnée. Par défaut, aucun délai d'inactivité n'est défini.

Si le délai d'inactivité du jeton est également configuré dans votre client OAuth, cette valeur remplace le délai défini dans la configuration interne du serveur OAuth.

Conditions préalables

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin. - Vous avez configuré un fournisseur d'identité (IDP).

Procédure

Mettre à jour la configuration de

OAuthpour définir un délai d'inactivité des jetons.Modifiez l'objet

OAuth:oc edit oauth cluster

$ oc edit oauth clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez le champ

spec.tokenConfig.accessTokenInactivityTimeoutet définissez la valeur de votre délai d'attente :Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Définissez une valeur avec les unités appropriées, par exemple

400spour 400 secondes, ou30mpour 30 minutes. La valeur minimale autorisée pour le délai d'attente est300s.

- Enregistrez le fichier pour appliquer les modifications.

Vérifier que les pods du serveur OAuth ont redémarré :

oc get clusteroperators authentication

$ oc get clusteroperators authenticationCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ne passez pas à l'étape suivante tant que

PROGRESSINGn'est pas répertorié commeFalse, comme le montre le résultat suivant :Exemple de sortie

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE authentication 4.12.0 True False False 145m

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE authentication 4.12.0 True False False 145mCopy to Clipboard Copied! Toggle word wrap Toggle overflow Vérifiez qu'une nouvelle révision des pods du serveur Kubernetes API a été déployée. Cela prendra plusieurs minutes.

oc get clusteroperators kube-apiserver

$ oc get clusteroperators kube-apiserverCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ne passez pas à l'étape suivante tant que

PROGRESSINGn'est pas répertorié commeFalse, comme le montre le résultat suivant :Exemple de sortie

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE kube-apiserver 4.12.0 True False False 145m

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE kube-apiserver 4.12.0 True False False 145mCopy to Clipboard Copied! Toggle word wrap Toggle overflow Si

PROGRESSINGafficheTrue, attendez quelques minutes et réessayez.

Vérification

- Connectez-vous au cluster avec l'identité de votre IDP.

- Exécuter une commande et vérifier qu'elle a abouti.

- Attendre plus longtemps que le délai configuré sans utiliser l'identité. Dans l'exemple de cette procédure, il faut attendre plus de 400 secondes.

Essayer d'exécuter une commande à partir de la session de la même identité.

Cette commande doit échouer car le jeton doit avoir expiré en raison d'une inactivité plus longue que le délai d'attente configuré.

Exemple de sortie

error: You must be logged in to the server (Unauthorized)

error: You must be logged in to the server (Unauthorized)Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6. Personnaliser l'URL interne du serveur OAuth

Vous pouvez personnaliser l'URL du serveur OAuth interne en définissant le nom d'hôte personnalisé et le certificat TLS dans le champ spec.componentRoutes de la configuration du cluster Ingress.

Si vous mettez à jour l'URL du serveur OAuth interne, vous risquez de perdre la confiance des composants du cluster qui ont besoin de communiquer avec le serveur OpenShift OAuth pour récupérer les jetons d'accès OAuth. Les composants qui ont besoin de faire confiance au serveur OAuth devront inclure le bundle CA approprié lors de l'appel des endpoints OAuth. Par exemple :

oc login -u <username> -p <password> --certificate-authority=<path_to_ca.crt>

$ oc login -u <username> -p <password> --certificate-authority=<path_to_ca.crt> - 1

- Pour les certificats auto-signés, le fichier

ca.crtdoit contenir le certificat personnalisé de l'autorité de certification, sinon la connexion n'aboutira pas.

L'opérateur d'authentification de cluster publie le certificat de service du serveur OAuth dans la carte de configuration oauth-serving-cert dans l'espace de noms openshift-config-managed. Vous pouvez trouver le certificat dans la clé data.ca-bundle.crt de la carte de configuration.

Conditions préalables

- Vous vous êtes connecté au cluster en tant qu'utilisateur disposant de privilèges administratifs.

Vous avez créé un secret dans l'espace de noms

openshift-configcontenant le certificat et la clé TLS. Cela est nécessaire si le domaine du suffixe du nom d'hôte personnalisé ne correspond pas au suffixe du domaine du cluster. Le secret est facultatif si le suffixe correspond.AstuceVous pouvez créer un secret TLS à l'aide de la commande

oc create secret tls.

Procédure

Modifiez la configuration du cluster

Ingress:oc edit ingress.config.openshift.io cluster

$ oc edit ingress.config.openshift.io clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow Définir le nom d'hôte personnalisé et, éventuellement, le certificat et la clé de service :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Le nom d'hôte personnalisé.

- 2

- Référence à un secret dans l'espace de noms

openshift-configqui contient un certificat TLS (tls.crt) et une clé (tls.key). Cette référence est obligatoire si le domaine du suffixe du nom d'hôte personnalisé ne correspond pas au suffixe du domaine du cluster. Le secret est facultatif si le suffixe correspond.

- Enregistrez le fichier pour appliquer les modifications.

3.7. Métadonnées du serveur OAuth

Les applications fonctionnant sur OpenShift Container Platform peuvent avoir à découvrir des informations sur le serveur OAuth intégré. Par exemple, elles peuvent avoir à découvrir l'adresse du site <namespace_route> sans configuration manuelle. Pour les aider, OpenShift Container Platform met en œuvre le projet de spécification IETF OAuth 2.0 Authorization Server Metadata.

Ainsi, toute application s'exécutant au sein du cluster peut envoyer une requête GET à https://openshift.default.svc/.well-known/oauth-authorization-server pour obtenir les informations suivantes :

- 1

- L'identifiant de l'émetteur du serveur d'autorisation, qui est une URL utilisant le schéma

httpset ne comportant aucun élément de requête ou de fragment. Il s'agit de l'emplacement où sont publiées les ressources.well-knownRFC 5785 contenant des informations sur le serveur d'autorisation. - 2

- URL du point final d'autorisation du serveur d'autorisation. Voir RFC 6749.

- 3

- URL du point de terminaison du jeton du serveur d'autorisation. Voir RFC 6749.

- 4

- Tableau JSON contenant une liste des valeurs d'étendue OAuth 2.0 RFC 6749 prises en charge par ce serveur d'autorisation. Notez que toutes les valeurs d'étendue prises en charge ne sont pas annoncées.

- 5

- Tableau JSON contenant une liste des valeurs OAuth 2.0

response_typeprises en charge par ce serveur d'autorisation. Les valeurs de tableau utilisées sont les mêmes que celles utilisées avec le paramètreresponse_typesdéfini par "OAuth 2.0 Dynamic Client Registration Protocol" dans la RFC 7591. - 6

- Tableau JSON contenant une liste des valeurs de type de subvention OAuth 2.0 prises en charge par ce serveur d'autorisation. Les valeurs du tableau utilisées sont les mêmes que celles utilisées avec le paramètre

grant_typesdéfini parOAuth 2.0 Dynamic Client Registration Protocoldans la RFC 7591. - 7

- Tableau JSON contenant une liste des méthodes de contestation de code PKCE RFC 7636 prises en charge par ce serveur d'autorisation. Les valeurs de ces méthodes sont utilisées dans le paramètre

code_challenge_methoddéfini dans la section 4.3 de la RFC 7636. Les valeurs valides de la méthode de contestation de code sont celles qui sont enregistrées dans le registrePKCE Code Challenge Methodsde l'IANA. Voir les paramètres OAuth de l'IANA.

3.8. Dépannage des événements de l'API OAuth

Dans certains cas, le serveur API renvoie un message d'erreur unexpected condition qui est difficile à déboguer sans accès direct au journal principal de l'API. La raison sous-jacente de l'erreur est volontairement masquée afin d'éviter de fournir à un utilisateur non authentifié des informations sur l'état du serveur.

Un sous-ensemble de ces erreurs est lié à des problèmes de configuration du compte de service OAuth. Ces problèmes sont capturés dans des événements qui peuvent être visualisés par des utilisateurs qui ne sont pas administrateurs. Lorsque vous rencontrez une erreur du serveur unexpected condition pendant OAuth, exécutez oc get events pour afficher ces événements sous ServiceAccount.

L'exemple suivant signale un compte de service dont l'URI de redirection OAuth n'est pas correct :

oc get events | grep ServiceAccount

$ oc get events | grep ServiceAccountExemple de sortie

1m 1m 1 proxy ServiceAccount Warning NoSAOAuthRedirectURIs service-account-oauth-client-getter system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>

1m 1m 1 proxy ServiceAccount Warning NoSAOAuthRedirectURIs service-account-oauth-client-getter system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>

L'exécution de oc describe sa/<service_account_name> rapporte tous les événements OAuth associés au nom du compte de service donné.

oc describe sa/proxy | grep -A5 Events

$ oc describe sa/proxy | grep -A5 EventsExemple de sortie

Events: FirstSeen LastSeen Count From SubObjectPath Type Reason Message --------- -------- ----- ---- ------------- -------- ------ ------- 3m 3m 1 service-account-oauth-client-getter Warning NoSAOAuthRedirectURIs system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>

Events:

FirstSeen LastSeen Count From SubObjectPath Type Reason Message

--------- -------- ----- ---- ------------- -------- ------ -------

3m 3m 1 service-account-oauth-client-getter Warning NoSAOAuthRedirectURIs system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>Voici une liste des erreurs d'événements possibles :

No redirect URI annotations or an invalid URI is specified

Reason Message NoSAOAuthRedirectURIs system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>

Reason Message

NoSAOAuthRedirectURIs system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>Invalid route specified

Reason Message NoSAOAuthRedirectURIs [routes.route.openshift.io "<name>" not found, system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>]

Reason Message

NoSAOAuthRedirectURIs [routes.route.openshift.io "<name>" not found, system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>]Invalid reference type specified

Reason Message NoSAOAuthRedirectURIs [no kind "<name>" is registered for version "v1", system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>]

Reason Message

NoSAOAuthRedirectURIs [no kind "<name>" is registered for version "v1", system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>]Missing SA tokens

Reason Message NoSAOAuthTokens system:serviceaccount:myproject:proxy has no tokens

Reason Message

NoSAOAuthTokens system:serviceaccount:myproject:proxy has no tokensChapitre 4. Configuration des clients OAuth

Plusieurs clients OAuth sont créés par défaut dans OpenShift Container Platform. Vous pouvez également enregistrer et configurer des clients OAuth supplémentaires.

4.1. Clients OAuth par défaut

Les clients OAuth suivants sont automatiquement créés lors du démarrage de l'API OpenShift Container Platform :

| Client OAuth | Utilisation |

|---|---|

|

|

Demande des jetons à |

|

|

Demande de jetons avec un user-agent qui peut gérer les défis |

<namespace_route>fait référence à la route de l'espace de noms. On le trouve en exécutant la commande suivante :oc get route oauth-openshift -n openshift-authentication -o json | jq .spec.host

$ oc get route oauth-openshift -n openshift-authentication -o json | jq .spec.hostCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2. Enregistrement d'un client OAuth supplémentaire

Si vous avez besoin d'un client OAuth supplémentaire pour gérer l'authentification de votre cluster OpenShift Container Platform, vous pouvez en enregistrer un.

Procédure

Pour enregistrer des clients OAuth supplémentaires :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- L'adresse

namedu client OAuth est utilisée comme paramètreclient_idlors des demandes adressées à<namespace_route>/oauth/authorizeet<namespace_route>/oauth/token. - 2

- L'adresse

secretest utilisée comme paramètre de l'adresseclient_secretlors des demandes adressées à l'adresse<namespace_route>/oauth/token. - 3

- Le paramètre

redirect_urispécifié dans les demandes adressées à<namespace_route>/oauth/authorizeet<namespace_route>/oauth/tokendoit être égal ou préfixé par l'un des URI énumérés dans la valeur du paramètreredirectURIs. - 4

- L'adresse

grantMethodest utilisée pour déterminer l'action à entreprendre lorsque ce client demande des jetons et que l'utilisateur ne lui a pas encore accordé l'accès. Indiquezautopour approuver automatiquement l'autorisation et relancer la demande, oupromptpour demander à l'utilisateur d'approuver ou de refuser l'autorisation.

4.3. Configuration du délai d'inactivité du jeton pour un client OAuth

Vous pouvez configurer les clients OAuth pour qu'ils expirent les jetons OAuth après une période d'inactivité donnée. Par défaut, aucun délai d'inactivité n'est défini.

Si le délai d'inactivité du jeton est également configuré dans la configuration interne du serveur OAuth, le délai défini dans le client OAuth remplace cette valeur.

Conditions préalables

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin. - Vous avez configuré un fournisseur d'identité (IDP).

Procédure

Mettre à jour la configuration de

OAuthClientpour définir un délai d'inactivité des jetons.Modifiez l'objet

OAuthClient:oc edit oauthclient <oauth_client>

oc edit oauthclient <oauth_client>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Remplacez

<oauth_client>par le client OAuth à configurer, par exempleconsole.

Ajoutez le champ

accessTokenInactivityTimeoutSecondset définissez la valeur de votre délai d'attente :Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- La valeur minimale autorisée du délai d'attente en secondes est de

300.

- Enregistrez le fichier pour appliquer les modifications.

Vérification

- Connectez-vous au cluster avec une identité provenant de votre IDP. Veillez à utiliser le client OAuth que vous venez de configurer.

- Effectuer une action et vérifier qu'elle a réussi.

- Attendre plus longtemps que le délai configuré sans utiliser l'identité. Dans l'exemple de cette procédure, attendez plus de 600 secondes.

Essayer d'effectuer une action à partir de la session de la même identité.

Cette tentative doit échouer car le jeton doit avoir expiré en raison d'une inactivité plus longue que le délai configuré.

Chapitre 5. Gestion des jetons d'accès OAuth appartenant à l'utilisateur

Les utilisateurs peuvent consulter leurs propres jetons d'accès OAuth et supprimer ceux qui ne sont plus nécessaires.

5.1. Liste des jetons d'accès OAuth appartenant à l'utilisateur

Vous pouvez dresser la liste des jetons d'accès OAuth appartenant à l'utilisateur. Les noms des jetons ne sont pas sensibles et ne peuvent pas être utilisés pour se connecter.

Procédure

Liste de tous les jetons d'accès OAuth appartenant à l'utilisateur :

oc get useroauthaccesstokens

$ oc get useroauthaccesstokensCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME CLIENT NAME CREATED EXPIRES REDIRECT URI SCOPES <token1> openshift-challenging-client 2021-01-11T19:25:35Z 2021-01-12 19:25:35 +0000 UTC https://oauth-openshift.apps.example.com/oauth/token/implicit user:full <token2> openshift-browser-client 2021-01-11T19:27:06Z 2021-01-12 19:27:06 +0000 UTC https://oauth-openshift.apps.example.com/oauth/token/display user:full <token3> console 2021-01-11T19:26:29Z 2021-01-12 19:26:29 +0000 UTC https://console-openshift-console.apps.example.com/auth/callback user:full

NAME CLIENT NAME CREATED EXPIRES REDIRECT URI SCOPES <token1> openshift-challenging-client 2021-01-11T19:25:35Z 2021-01-12 19:25:35 +0000 UTC https://oauth-openshift.apps.example.com/oauth/token/implicit user:full <token2> openshift-browser-client 2021-01-11T19:27:06Z 2021-01-12 19:27:06 +0000 UTC https://oauth-openshift.apps.example.com/oauth/token/display user:full <token3> console 2021-01-11T19:26:29Z 2021-01-12 19:26:29 +0000 UTC https://console-openshift-console.apps.example.com/auth/callback user:fullCopy to Clipboard Copied! Toggle word wrap Toggle overflow Liste des jetons d'accès OAuth appartenant à l'utilisateur pour un client OAuth particulier :

oc get useroauthaccesstokens --field-selector=clientName="console"

$ oc get useroauthaccesstokens --field-selector=clientName="console"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME CLIENT NAME CREATED EXPIRES REDIRECT URI SCOPES <token3> console 2021-01-11T19:26:29Z 2021-01-12 19:26:29 +0000 UTC https://console-openshift-console.apps.example.com/auth/callback user:full

NAME CLIENT NAME CREATED EXPIRES REDIRECT URI SCOPES <token3> console 2021-01-11T19:26:29Z 2021-01-12 19:26:29 +0000 UTC https://console-openshift-console.apps.example.com/auth/callback user:fullCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2. Afficher les détails d'un jeton d'accès OAuth appartenant à un utilisateur

Vous pouvez afficher les détails d'un jeton d'accès OAuth appartenant à un utilisateur.

Procédure

Décrire les détails d'un jeton d'accès OAuth appartenant à un utilisateur :

oc describe useroauthaccesstokens <token_name>

oc describe useroauthaccesstokens <token_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Le nom du jeton, qui est le hachage sha256 du jeton. Les noms de jetons ne sont pas sensibles et ne peuvent pas être utilisés pour se connecter.

- 2

- Le nom du client, qui décrit l'origine du jeton.

- 3

- La valeur en secondes à partir de l'heure de création avant que ce jeton n'expire.

- 4

- Si le serveur OAuth a défini un délai d'inactivité pour le jeton, il s'agit de la valeur en secondes à partir de l'heure de création avant que ce jeton ne puisse plus être utilisé.

- 5

- Les champs d'application de ce jeton.

- 6

- Le nom d'utilisateur associé à ce jeton.

5.3. Suppression des jetons d'accès OAuth appartenant à l'utilisateur

La commande oc logout invalide uniquement le jeton OAuth de la session active. Vous pouvez utiliser la procédure suivante pour supprimer tous les jetons OAuth appartenant à l'utilisateur qui ne sont plus nécessaires.

La suppression d'un jeton d'accès OAuth déconnecte l'utilisateur de toutes les sessions qui utilisent le jeton.

Procédure

Supprimer le jeton d'accès OAuth appartenant à l'utilisateur :

oc delete useroauthaccesstokens <token_name>

oc delete useroauthaccesstokens <token_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

useroauthaccesstoken.oauth.openshift.io "<token_name>" supprimé

useroauthaccesstoken.oauth.openshift.io "<token_name>" suppriméCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Chapitre 6. Comprendre la configuration du fournisseur d'identité

Le master OpenShift Container Platform comprend un serveur OAuth intégré. Les développeurs et les administrateurs obtiennent des jetons d'accès OAuth pour s'authentifier auprès de l'API.

En tant qu'administrateur, vous pouvez configurer OAuth pour qu'il spécifie un fournisseur d'identité après l'installation de votre cluster.

6.1. À propos des fournisseurs d'identité dans OpenShift Container Platform

Par défaut, seul un utilisateur kubeadmin existe sur votre cluster. Pour spécifier un fournisseur d'identité, vous devez créer une ressource personnalisée (CR) qui décrit ce fournisseur d'identité et l'ajouter au cluster.

Les noms d'utilisateur OpenShift Container Platform contenant /, :, et % ne sont pas pris en charge.

6.2. Fournisseurs d'identité pris en charge

Vous pouvez configurer les types de fournisseurs d'identité suivants :

| Fournisseur d'identité | Description |

|---|---|

|

Configurer le fournisseur d'identité | |

|

Configurez le fournisseur d'identité | |

|

Configurer le fournisseur d'identité | |

|

Configurer un fournisseur d'identité | |

|

Configurez un fournisseur d'identité | |

|

Configurez un fournisseur d'identité | |

|

Configurer un fournisseur d'identité | |

|

Configurer un fournisseur d'identité | |

|

Configurer un fournisseur d'identité |

Une fois qu'un fournisseur d'identité a été défini, vous pouvez utiliser RBAC pour définir et appliquer des autorisations.

6.3. Suppression de l'utilisateur kubeadmin

Après avoir défini un fournisseur d'identité et créé un nouvel utilisateur cluster-admin, vous pouvez supprimer le site kubeadmin pour améliorer la sécurité du cluster.

Si vous suivez cette procédure avant qu'un autre utilisateur ne soit cluster-admin, OpenShift Container Platform doit être réinstallé. Il n'est pas possible d'annuler cette commande.

Conditions préalables

- Vous devez avoir configuré au moins un fournisseur d'identité.

-

Vous devez avoir ajouté le rôle

cluster-adminà un utilisateur. - Vous devez être connecté en tant qu'administrateur.

Procédure

Supprimez les secrets de

kubeadmin:oc delete secrets kubeadmin -n kube-system

$ oc delete secrets kubeadmin -n kube-systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4. Paramètres du fournisseur d'identité

Les paramètres suivants sont communs à tous les fournisseurs d'identité :

| Paramètres | Description |

|---|---|

|

| Le nom du fournisseur est préfixé aux noms des utilisateurs du fournisseur pour former un nom d'identité. |

|

| Définit la manière dont les nouvelles identités sont associées aux utilisateurs lorsqu'ils se connectent. Entrez l'une des valeurs suivantes :

|

Lorsque vous ajoutez ou modifiez des fournisseurs d'identité, vous pouvez faire correspondre les identités du nouveau fournisseur aux utilisateurs existants en définissant le paramètre mappingMethod sur add.

6.5. Exemple de CR de fournisseur d'identité

La ressource personnalisée (CR) suivante montre les paramètres et les valeurs par défaut que vous utilisez pour configurer un fournisseur d'identité. Cet exemple utilise le fournisseur d'identité htpasswd.

Exemple de CR de fournisseur d'identité

Chapitre 7. Configuration des fournisseurs d'identité

7.1. Configuration d'un fournisseur d'identité htpasswd

Configurez le fournisseur d'identité htpasswd pour permettre aux utilisateurs de se connecter à OpenShift Container Platform avec des informations d'identification provenant d'un fichier htpasswd.

Pour définir un fournisseur d'identité htpasswd, effectuez les tâches suivantes :

-

Créez un fichier

htpasswdpour stocker les informations relatives à l'utilisateur et au mot de passe. -

Créer un secret pour représenter le fichier

htpasswd. - Définir une ressource fournisseur d'identité htpasswd qui référence le secret.

- Appliquer la ressource à la configuration OAuth par défaut pour ajouter le fournisseur d'identité.

7.1.1. À propos des fournisseurs d'identité dans OpenShift Container Platform

Par défaut, seul un utilisateur kubeadmin existe sur votre cluster. Pour spécifier un fournisseur d'identité, vous devez créer une ressource personnalisée (CR) qui décrit ce fournisseur d'identité et l'ajouter au cluster.

Les noms d'utilisateur OpenShift Container Platform contenant /, :, et % ne sont pas pris en charge.

7.1.2. A propos de l'authentification htpasswd

L'utilisation de l'authentification htpasswd dans OpenShift Container Platform vous permet d'identifier les utilisateurs sur la base d'un fichier htpasswd. Un fichier htpasswd est un fichier plat qui contient le nom d'utilisateur et le mot de passe haché de chaque utilisateur. Vous pouvez utiliser l'utilitaire htpasswd pour créer ce fichier.

7.1.3. Création du fichier htpasswd

Consultez l'une des sections suivantes pour savoir comment créer le fichier htpasswd :

7.1.3.1. Création d'un fichier htpasswd sous Linux

Pour utiliser le fournisseur d'identité htpasswd, vous devez générer un fichier plat contenant les noms d'utilisateur et les mots de passe de votre cluster à l'aide de la commande htpasswd.

Conditions préalables

-

Avoir accès à l'utilitaire

htpasswd. Sur Red Hat Enterprise Linux, cet utilitaire est disponible en installant le paquetagehttpd-tools.

Procédure

Créez ou mettez à jour votre fichier plat avec un nom d'utilisateur et un mot de passe haché :

htpasswd -c -B -b </path/to/users.htpasswd> <user_name> <password>

$ htpasswd -c -B -b </path/to/users.htpasswd> <user_name> <password>Copy to Clipboard Copied! Toggle word wrap Toggle overflow La commande génère une version hachée du mot de passe.

Par exemple :

htpasswd -c -B -b users.htpasswd user1 MyPassword!

$ htpasswd -c -B -b users.htpasswd user1 MyPassword!Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Adding password for user user1

Adding password for user user1Copy to Clipboard Copied! Toggle word wrap Toggle overflow Continuez à ajouter ou à mettre à jour les informations d'identification dans le fichier :

htpasswd -B -b </path/to/users.htpasswd> <user_name> <password>

$ htpasswd -B -b </path/to/users.htpasswd> <user_name> <password>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.1.3.2. Création d'un fichier htpasswd sous Windows

Pour utiliser le fournisseur d'identité htpasswd, vous devez générer un fichier plat contenant les noms d'utilisateur et les mots de passe de votre cluster à l'aide de la commande htpasswd.

Conditions préalables

-

Avoir accès à

htpasswd.exe. Ce fichier est inclus dans le répertoire\binde nombreuses distributions d'Apache httpd.

Procédure

Créez ou mettez à jour votre fichier plat avec un nom d'utilisateur et un mot de passe haché :

> htpasswd.exe -c -B -b <\path\to\users.htpasswd> < nom_utilisateur> <mot_de_passe>

> htpasswd.exe -c -B -b <\path\to\users.htpasswd> < nom_utilisateur> <mot_de_passe>Copy to Clipboard Copied! Toggle word wrap Toggle overflow La commande génère une version hachée du mot de passe.

Par exemple :

> htpasswd.exe -c -B -b users.htpasswd user1 MyPassword !

> htpasswd.exe -c -B -b users.htpasswd user1 MyPassword !Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Adding password for user user1

Adding password for user user1Copy to Clipboard Copied! Toggle word wrap Toggle overflow Continuez à ajouter ou à mettre à jour les informations d'identification dans le fichier :

> htpasswd.exe -b <\pathto\users.htpasswd> < nom_utilisateur> <mot_de_passe>

> htpasswd.exe -b <\pathto\users.htpasswd> < nom_utilisateur> <mot_de_passe>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.1.4. Création du secret htpasswd

Pour utiliser le fournisseur d'identité htpasswd, vous devez définir un secret contenant le fichier utilisateur htpasswd.

Conditions préalables

- Créer un fichier htpasswd.

Procédure

Créez un objet

Secretqui contient le fichier htpasswd users :oc create secret generic htpass-secret --from-file=htpasswd=<path_to_users.htpasswd> -n openshift-config

$ oc create secret generic htpass-secret --from-file=htpasswd=<path_to_users.htpasswd> -n openshift-config1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- La clé secrète contenant le fichier des utilisateurs pour l'argument

--from-filedoit être nomméehtpasswd, comme indiqué dans la commande ci-dessus.

AstuceVous pouvez également appliquer le code YAML suivant pour créer le secret :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.1.5. Exemple de CR htpasswd

La ressource personnalisée (CR) suivante présente les paramètres et les valeurs acceptables pour un fournisseur d'identité htpasswd.

htpasswd CR

7.1.6. Ajouter un fournisseur d'identité à votre cluster

Après avoir installé votre cluster, ajoutez-y un fournisseur d'identité pour que vos utilisateurs puissent s'authentifier.

Conditions préalables

- Créer un cluster OpenShift Container Platform.

- Créez la ressource personnalisée (CR) pour vos fournisseurs d'identité.

- Vous devez être connecté en tant qu'administrateur.

Procédure

Appliquer le CR défini :

oc apply -f </path/to/CR>

$ oc apply -f </path/to/CR>Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteSi un CR n'existe pas,

oc applycrée un nouveau CR et peut déclencher l'avertissement suivant :Warning: oc apply should be used on resources created by either oc create --save-config or oc apply. Dans ce cas, vous pouvez ignorer cet avertissement.Connectez-vous au cluster en tant qu'utilisateur de votre fournisseur d'identité, en saisissant le mot de passe lorsque vous y êtes invité.

oc login -u <nom d'utilisateur>

$ oc login -u <nom d'utilisateur>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Confirmez que l'utilisateur s'est connecté avec succès et affichez le nom de l'utilisateur.

oc whoami

$ oc whoamiCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.1.7. Mise à jour des utilisateurs d'un fournisseur d'identité htpasswd

Vous pouvez ajouter ou supprimer des utilisateurs d'un fournisseur d'identité htpasswd existant.

Conditions préalables

-

Vous avez créé un objet

Secretqui contient le fichier utilisateur htpasswd. Cette procédure suppose qu'il est nomméhtpass-secret. -

Vous avez configuré un fournisseur d'identité htpasswd. Cette procédure suppose qu'il s'appelle

my_htpasswd_provider. -

Vous avez accès à l'utilitaire

htpasswd. Sur Red Hat Enterprise Linux, cet utilitaire est disponible en installant le paquetagehttpd-tools. - Vous avez des privilèges d'administrateur de cluster.

Procédure

Récupérez le fichier htpasswd de l'objet

htpass-secretSecretet enregistrez le fichier sur votre système de fichiers :oc get secret htpass-secret -ojsonpath={.data.htpasswd} -n openshift-config | base64 --decode > users.htpasswd$ oc get secret htpass-secret -ojsonpath={.data.htpasswd} -n openshift-config | base64 --decode > users.htpasswdCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajouter ou supprimer des utilisateurs du fichier

users.htpasswd.Pour ajouter un nouvel utilisateur :

htpasswd -bB users.htpasswd <nom d'utilisateur> <mot de passe>

$ htpasswd -bB users.htpasswd <nom d'utilisateur> <mot de passe>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Ajout d'un mot de passe pour l'utilisateur <nom d'utilisateur>

Ajout d'un mot de passe pour l'utilisateur <nom d'utilisateur>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Pour supprimer un utilisateur existant :

htpasswd -D users.htpasswd <username>

$ htpasswd -D users.htpasswd <username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Suppression du mot de passe de l'utilisateur <nom d'utilisateur>

Suppression du mot de passe de l'utilisateur <nom d'utilisateur>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Remplacez l'objet

htpass-secretSecretpar les utilisateurs mis à jour dans le fichierusers.htpasswd:oc create secret generic htpass-secret --from-file=htpasswd=users.htpasswd --dry-run=client -o yaml -n openshift-config | oc replace -f -

$ oc create secret generic htpass-secret --from-file=htpasswd=users.htpasswd --dry-run=client -o yaml -n openshift-config | oc replace -f -Copy to Clipboard Copied! Toggle word wrap Toggle overflow AstuceVous pouvez également appliquer le YAML suivant pour remplacer le secret :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Si vous avez supprimé un ou plusieurs utilisateurs, vous devez également supprimer les ressources existantes pour chaque utilisateur.

Supprimer l'objet

User:oc delete user <username>

$ oc delete user <username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

user.user.openshift.io "<username>" supprimé

user.user.openshift.io "<username>" suppriméCopy to Clipboard Copied! Toggle word wrap Toggle overflow Veillez à supprimer l'utilisateur, sinon il pourra continuer à utiliser son jeton tant qu'il n'aura pas expiré.

Supprimer l'objet

Identitypour l'utilisateur :oc delete identity my_htpasswd_provider:<username> $ oc delete identity my_htpasswd_provider:<username>

oc delete identity my_htpasswd_provider:<username> $ oc delete identity my_htpasswd_provider:<username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

identity.user.openshift.io "my_htpasswd_provider:<username>" supprimé

identity.user.openshift.io "my_htpasswd_provider:<username>" suppriméCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.1.8. Configuration des fournisseurs d'identité à l'aide de la console web

Configurez votre fournisseur d'identité (IDP) via la console web au lieu de l'interface CLI.

Conditions préalables

- Vous devez être connecté à la console web en tant qu'administrateur de cluster.

Procédure

- Naviguez jusqu'à Administration → Cluster Settings.

- Sous l'onglet Configuration, cliquez sur OAuth.

- Dans la section Identity Providers, sélectionnez votre fournisseur d'identité dans le menu déroulant Add.

Vous pouvez spécifier plusieurs IDP via la console web sans écraser les IDP existants.

7.2. Configuration d'un fournisseur d'identité Keystone

Configurez le fournisseur d'identité keystone pour intégrer votre cluster OpenShift Container Platform avec Keystone afin d'activer l'authentification partagée avec un serveur OpenStack Keystone v3 configuré pour stocker les utilisateurs dans une base de données interne. Cette configuration permet aux utilisateurs de se connecter à OpenShift Container Platform avec leurs informations d'identification Keystone.

7.2.1. À propos des fournisseurs d'identité dans OpenShift Container Platform

Par défaut, seul un utilisateur kubeadmin existe sur votre cluster. Pour spécifier un fournisseur d'identité, vous devez créer une ressource personnalisée (CR) qui décrit ce fournisseur d'identité et l'ajouter au cluster.

Les noms d'utilisateur OpenShift Container Platform contenant /, :, et % ne sont pas pris en charge.

7.2.2. À propos de l'authentification Keystone

Keystone est un projet OpenStack qui fournit des services d'identité, de jeton, de catalogue et de politique.

Vous pouvez configurer l'intégration avec Keystone pour que les nouveaux utilisateurs d'OpenShift Container Platform soient basés sur les noms d'utilisateurs Keystone ou les identifiants uniques Keystone. Avec les deux méthodes, les utilisateurs se connectent en entrant leur nom d'utilisateur et leur mot de passe Keystone. Baser les utilisateurs d'OpenShift Container Platform sur l'ID Keystone est plus sûr car si vous supprimez un utilisateur Keystone et créez un nouvel utilisateur Keystone avec ce nom d'utilisateur, le nouvel utilisateur pourrait avoir accès aux ressources de l'ancien utilisateur.

7.2.3. Création du secret

Les fournisseurs d'identité utilisent des objets OpenShift Container Platform Secret dans l'espace de noms openshift-config pour contenir le secret du client, les certificats du client et les clés.

Procédure

Créez un objet

Secretcontenant la clé et le certificat à l'aide de la commande suivante :oc create secret tls <secret_name> --key=key.pem --cert=cert.pem -n openshift-config

$ oc create secret tls <secret_name> --key=key.pem --cert=cert.pem -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow AstuceVous pouvez également appliquer le code YAML suivant pour créer le secret :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.4. Création d'une carte de configuration

Les fournisseurs d'identité utilisent les objets OpenShift Container Platform ConfigMap dans l'espace de noms openshift-config pour contenir le paquet de l'autorité de certification. Ces objets sont principalement utilisés pour contenir les paquets de certificats nécessaires au fournisseur d'identité.

Procédure

Définissez un objet OpenShift Container Platform

ConfigMapcontenant l'autorité de certification en utilisant la commande suivante. L'autorité de certification doit être stockée dans la cléca.crtde l'objetConfigMap.oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config

$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow AstuceVous pouvez également appliquer le YAML suivant pour créer la carte de configuration :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.5. Exemple de Keystone CR

La ressource personnalisée (CR) suivante présente les paramètres et les valeurs acceptables pour un fournisseur d'identité Keystone.

Keystone CR

- 1

- Ce nom de fournisseur est préfixé aux noms d'utilisateurs du fournisseur pour former un nom d'identité.

- 2

- Contrôle la manière dont les correspondances sont établies entre les identités de ce fournisseur et les objets

User. - 3

- Nom de domaine Keystone. Dans Keystone, les noms d'utilisateur sont spécifiques à un domaine. Un seul domaine est pris en charge.

- 4

- L'URL à utiliser pour se connecter au serveur Keystone (obligatoire). Elle doit utiliser https.

- 5

- Facultatif : Référence à un objet OpenShift Container Platform

ConfigMapcontenant le bundle de l'autorité de certification codé en PEM à utiliser pour valider les certificats du serveur pour l'URL configurée. - 6

- Facultatif : Référence à un objet OpenShift Container Platform

Secretcontenant le certificat client à présenter lors des requêtes à l'URL configurée. - 7

- Référence à un objet OpenShift Container Platform

Secretcontenant la clé du certificat client. Requis sitlsClientCertest spécifié.

7.2.6. Ajouter un fournisseur d'identité à votre cluster

Après avoir installé votre cluster, ajoutez-y un fournisseur d'identité pour que vos utilisateurs puissent s'authentifier.

Conditions préalables

- Créer un cluster OpenShift Container Platform.

- Créez la ressource personnalisée (CR) pour vos fournisseurs d'identité.

- Vous devez être connecté en tant qu'administrateur.

Procédure

Appliquer le CR défini :

oc apply -f </path/to/CR>

$ oc apply -f </path/to/CR>Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteSi un CR n'existe pas,

oc applycrée un nouveau CR et peut déclencher l'avertissement suivant :Warning: oc apply should be used on resources created by either oc create --save-config or oc apply. Dans ce cas, vous pouvez ignorer cet avertissement.Connectez-vous au cluster en tant qu'utilisateur de votre fournisseur d'identité, en saisissant le mot de passe lorsque vous y êtes invité.

oc login -u <nom d'utilisateur>

$ oc login -u <nom d'utilisateur>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Confirmez que l'utilisateur s'est connecté avec succès et affichez le nom de l'utilisateur.

oc whoami

$ oc whoamiCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3. Configuration d'un fournisseur d'identité LDAP

Configurer le fournisseur d'identité ldap pour valider les noms d'utilisateur et les mots de passe par rapport à un serveur LDAPv3, en utilisant l'authentification par liaison simple.

7.3.1. À propos des fournisseurs d'identité dans OpenShift Container Platform

Par défaut, seul un utilisateur kubeadmin existe sur votre cluster. Pour spécifier un fournisseur d'identité, vous devez créer une ressource personnalisée (CR) qui décrit ce fournisseur d'identité et l'ajouter au cluster.

Les noms d'utilisateur OpenShift Container Platform contenant /, :, et % ne sont pas pris en charge.

7.3.2. À propos de l'authentification LDAP

Lors de l'authentification, l'annuaire LDAP est parcouru à la recherche d'une entrée correspondant au nom d'utilisateur fourni. Si une correspondance unique est trouvée, une liaison simple est tentée en utilisant le nom distinctif (DN) de l'entrée et le mot de passe fourni.

Telles sont les mesures prises :

-

Générer un filtre de recherche en combinant l'attribut et le filtre dans le site

urlconfiguré avec le nom d'utilisateur fourni par l'utilisateur. - Effectuez une recherche dans le répertoire à l'aide du filtre généré. Si la recherche ne renvoie pas exactement une entrée, l'accès est refusé.

- Tentative de connexion au serveur LDAP à l'aide du DN de l'entrée récupérée lors de la recherche et du mot de passe fourni par l'utilisateur.

- Si la liaison n'aboutit pas, l'accès est refusé.

- Si la liaison est réussie, créez une identité en utilisant les attributs configurés comme identité, adresse électronique, nom d'affichage et nom d'utilisateur préféré.

L'adresse url configurée est une URL RFC 2255, qui spécifie l'hôte LDAP et les paramètres de recherche à utiliser. La syntaxe de l'URL est la suivante :

ldap://host:port/basedn?attribute?scope?filter

ldap://host:port/basedn?attribute?scope?filterPour cette URL :

| Composant URL | Description |

|---|---|

|

|

Pour le LDAP normal, utilisez la chaîne |

|

|

Le nom et le port du serveur LDAP. La valeur par défaut est |

|

| Le DN de la branche du répertoire à partir de laquelle toutes les recherches doivent commencer. Au minimum, il doit s'agir du sommet de l'arborescence de votre répertoire, mais il peut également s'agir d'une sous-arborescence du répertoire. |

|

|

L'attribut à rechercher. Bien que la RFC 2255 autorise une liste d'attributs séparés par des virgules, seul le premier attribut sera utilisé, quel que soit le nombre d'attributs fournis. Si aucun attribut n'est fourni, la valeur par défaut est |

|

|

L'étendue de la recherche. Il peut s'agir de |

|

|

Un filtre de recherche LDAP valide. S'il n'est pas fourni, la valeur par défaut est |

Lors des recherches, l'attribut, le filtre et le nom d'utilisateur fourni sont combinés pour créer un filtre de recherche qui se présente comme suit :

(&(<filtre>)(<attribut>=<nom d'utilisateur>)))

(&(<filtre>)(<attribut>=<nom d'utilisateur>)))Prenons l'exemple d'une URL de :

ldap://ldap.example.com/o=Acme?cn?sub?(enabled=true)

ldap://ldap.example.com/o=Acme?cn?sub?(enabled=true)

Lorsqu'un client tente de se connecter en utilisant le nom d'utilisateur bob, le filtre de recherche résultant sera (&(enabled=true)(cn=bob)).

Si l'annuaire LDAP nécessite une authentification pour la recherche, indiquez un bindDN et un bindPassword à utiliser pour effectuer la recherche d'entrée.

7.3.3. Création du secret LDAP

Pour utiliser le fournisseur d'identité, vous devez définir un objet OpenShift Container Platform Secret qui contient le champ bindPassword.

Procédure

Créez un objet

Secretqui contient le champbindPassword:oc create secret generic ldap-secret --from-literal=bindPassword=<secret> -n openshift-config

$ oc create secret generic ldap-secret --from-literal=bindPassword=<secret> -n openshift-config1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- La clé secrète contenant le mot de passe de liaison pour l'argument

--from-literaldoit être appeléebindPassword.

AstuceVous pouvez également appliquer le code YAML suivant pour créer le secret :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3.4. Création d'une carte de configuration

Les fournisseurs d'identité utilisent les objets OpenShift Container Platform ConfigMap dans l'espace de noms openshift-config pour contenir le paquet de l'autorité de certification. Ces objets sont principalement utilisés pour contenir les paquets de certificats nécessaires au fournisseur d'identité.

Procédure

Définissez un objet OpenShift Container Platform

ConfigMapcontenant l'autorité de certification en utilisant la commande suivante. L'autorité de certification doit être stockée dans la cléca.crtde l'objetConfigMap.oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config

$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow AstuceVous pouvez également appliquer le YAML suivant pour créer la carte de configuration :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3.5. Exemple de CR LDAP

La ressource personnalisée (CR) suivante présente les paramètres et les valeurs acceptables pour un fournisseur d'identité LDAP.

LDAP CR

- 1

- Ce nom de fournisseur est préfixé à l'identifiant de l'utilisateur renvoyé pour former un nom d'identité.

- 2

- Contrôle la manière dont les correspondances sont établies entre les identités de ce fournisseur et les objets

User. - 3

- Liste des attributs à utiliser comme identité. Le premier attribut non vide est utilisé. Au moins un attribut est requis. Si aucun des attributs énumérés n'a de valeur, l'authentification échoue. Les attributs définis sont récupérés sous forme brute, ce qui permet d'utiliser des valeurs binaires.

- 4

- Liste des attributs à utiliser comme adresse électronique. Le premier attribut non vide est utilisé.

- 5

- Liste des attributs à utiliser comme nom d'affichage. Le premier attribut non vide est utilisé.

- 6

- Liste d'attributs à utiliser comme nom d'utilisateur préféré lors du provisionnement d'un utilisateur pour cette identité. Le premier attribut non vide est utilisé.

- 7

- DN facultatif à utiliser pour se lier pendant la phase de recherche. Doit être défini si

bindPasswordest défini. - 8

- Référence optionnelle à un objet OpenShift Container Platform

Secretcontenant le mot de passe de liaison. Doit être défini sibindDNest défini. - 9

- Facultatif : Référence à un objet OpenShift Container Platform

ConfigMapcontenant le paquet d'autorité de certification codé PEM à utiliser dans la validation des certificats de serveur pour l'URL configurée. Utilisé uniquement lorsqueinsecureestfalse. - 10

- Lorsque

true, aucune connexion TLS n'est établie avec le serveur. Lorsquefalse, les URLldaps://se connectent en utilisant TLS, et les URLldap://sont mis à niveau vers TLS. Ce paramètre doit être défini surfalselorsque les URLldaps://sont utilisées, car ces URL tentent toujours de se connecter à l'aide de TLS. - 11

- URL RFC 2255 qui spécifie l'hôte LDAP et les paramètres de recherche à utiliser.

Pour établir une liste blanche d'utilisateurs pour une intégration LDAP, utilisez la méthode de mappage lookup. Avant d'autoriser une connexion à partir de LDAP, un administrateur de cluster doit créer un objet Identity et un objet User pour chaque utilisateur LDAP.

7.3.6. Ajouter un fournisseur d'identité à votre cluster

Après avoir installé votre cluster, ajoutez-y un fournisseur d'identité pour que vos utilisateurs puissent s'authentifier.

Conditions préalables

- Créer un cluster OpenShift Container Platform.

- Créez la ressource personnalisée (CR) pour vos fournisseurs d'identité.

- Vous devez être connecté en tant qu'administrateur.

Procédure

Appliquer le CR défini :

oc apply -f </path/to/CR>

$ oc apply -f </path/to/CR>Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteSi un CR n'existe pas,

oc applycrée un nouveau CR et peut déclencher l'avertissement suivant :Warning: oc apply should be used on resources created by either oc create --save-config or oc apply. Dans ce cas, vous pouvez ignorer cet avertissement.Connectez-vous au cluster en tant qu'utilisateur de votre fournisseur d'identité, en saisissant le mot de passe lorsque vous y êtes invité.

oc login -u <nom d'utilisateur>

$ oc login -u <nom d'utilisateur>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Confirmez que l'utilisateur s'est connecté avec succès et affichez le nom de l'utilisateur.

oc whoami

$ oc whoamiCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4. Configuration d'un fournisseur d'identité pour l'authentification de base

Configurer le fournisseur d'identité basic-authentication pour que les utilisateurs puissent se connecter à OpenShift Container Platform avec des informations d'identification validées par rapport à un fournisseur d'identité distant. L'authentification de base est un mécanisme d'intégration générique.

7.4.1. À propos des fournisseurs d'identité dans OpenShift Container Platform

Par défaut, seul un utilisateur kubeadmin existe sur votre cluster. Pour spécifier un fournisseur d'identité, vous devez créer une ressource personnalisée (CR) qui décrit ce fournisseur d'identité et l'ajouter au cluster.

Les noms d'utilisateur OpenShift Container Platform contenant /, :, et % ne sont pas pris en charge.

7.4.2. A propos de l'authentification de base

L'authentification de base est un mécanisme d'intégration générique qui permet aux utilisateurs de se connecter à OpenShift Container Platform avec des informations d'identification validées par un fournisseur d'identité distant.

L'authentification de base étant générique, vous pouvez utiliser ce fournisseur d'identité pour des configurations d'authentification avancées.

L'authentification de base doit utiliser une connexion HTTPS avec le serveur distant afin d'éviter que l'identifiant et le mot de passe de l'utilisateur ne soient espionnés et que des attaques de type "man-in-the-middle" ne se produisent.

Lorsque l'authentification de base est configurée, les utilisateurs envoient leur nom d'utilisateur et leur mot de passe à OpenShift Container Platform, qui valide ensuite ces informations d'identification auprès d'un serveur distant en effectuant une requête de serveur à serveur, en transmettant les informations d'identification en tant qu'en-tête d'authentification de base. Les utilisateurs doivent donc envoyer leurs informations d'identification à OpenShift Container Platform lors de la connexion.

Cela ne fonctionne que pour les mécanismes de connexion par nom d'utilisateur/mot de passe, et OpenShift Container Platform doit être en mesure de faire des demandes de réseau au serveur d'authentification distant.

Les noms d'utilisateur et les mots de passe sont validés par rapport à une URL distante qui est protégée par une authentification de base et renvoie du JSON.

Une réponse 401 indique que l'authentification a échoué.

Un état non200 ou la présence d'une clé "error" non vide indique une erreur :

{"error":"Error message"}

{"error":"Error message"}

Un statut 200 avec une clé sub (sujet) indique un succès :

{\i1}"sub":\N-"userid" }

{\i1}"sub":\N-"userid" } - 1

- Le sujet doit être unique pour l'utilisateur authentifié et ne doit pas pouvoir être modifié.

Une réponse positive peut éventuellement fournir des données supplémentaires, telles que

Un nom d'affichage à l'aide de la touche