Sans serveur

Installation, utilisation et notes de version d'OpenShift Serverless

Résumé

Chapitre 1. Notes de mise à jour

Pour plus d'informations sur le cycle de vie d'OpenShift Serverless et les plateformes prises en charge, consultez la Politique relative au cycle de vie des plateformes.

Les notes de version contiennent des informations sur les fonctionnalités nouvelles et obsolètes, les changements de rupture et les problèmes connus. Les notes de version suivantes s'appliquent aux versions les plus récentes d'OpenShift Serverless sur OpenShift Container Platform.

Pour une vue d'ensemble des fonctionnalités d'OpenShift Serverless, voir À propos d'OpenShift Serverless.

OpenShift Serverless est basé sur le projet open source Knative.

Pour plus de détails sur les dernières versions des composants Knative, consultez le blog Knative.

1.1. À propos des versions de l'API

Les versions d'API sont une mesure importante de l'état de développement de certaines fonctionnalités et ressources personnalisées dans OpenShift Serverless. La création de ressources sur votre cluster qui n'utilisent pas la bonne version d'API peut entraîner des problèmes dans votre déploiement.

L'OpenShift Serverless Operator met automatiquement à jour les anciennes ressources qui utilisent des versions obsolètes d'API pour utiliser la dernière version. Par exemple, si vous avez créé des ressources sur votre cluster qui utilisent des versions plus anciennes de l'API ApiServerSource, telles que v1beta1, l'OpenShift Serverless Operator met automatiquement à jour ces ressources pour utiliser la version v1 de l'API lorsqu'elle est disponible et que la version v1beta1 est obsolète.

Une fois qu'elles sont devenues obsolètes, les anciennes versions des API peuvent être supprimées dans une prochaine version. L'utilisation de versions obsolètes des API n'entraîne pas l'échec des ressources. Toutefois, si vous essayez d'utiliser une version d'une API qui a été supprimée, les ressources échoueront. Assurez-vous que vos manifestes sont mis à jour pour utiliser la dernière version afin d'éviter tout problème.

1.2. Fonctionnalités disponibles en général et en avant-première technologique

Les fonctionnalités qui sont généralement disponibles (GA) sont entièrement prises en charge et conviennent à une utilisation en production. Les fonctionnalités de Technology Preview (TP) sont des fonctionnalités expérimentales et ne sont pas destinées à une utilisation en production. Consultez l'étendue de l'assistance de l'aperçu technologique sur le portail client de Red Hat pour plus d'informations sur les fonctionnalités TP.

Le tableau suivant fournit des informations sur les fonctionnalités OpenShift Serverless qui sont GA et celles qui sont TP :

| Fonctionnalité | 1.26 | 1.27 | 1.28 |

|---|---|---|---|

|

| GA | GA | GA |

| Fonctions de Quarkus | GA | GA | GA |

| Fonctions Node.js | TP | TP | GA |

| Fonctions TypeScript | TP | TP | GA |

| Fonctions Python | - | - | TP |

| Service Mesh mTLS | GA | GA | GA |

|

| GA | GA | GA |

| Redirection HTTPS | GA | GA | GA |

| Courtier Kafka | GA | GA | GA |

| Puits Kafka | GA | GA | GA |

| Support des conteneurs Init pour les services Knative | GA | GA | GA |

| Soutien du PVC aux services Knative | GA | GA | GA |

| TLS pour le trafic interne | TP | TP | TP |

| Courtiers à espace de nommage | - | TP | TP |

|

| - | - | TP |

1.3. Fonctionnalités obsolètes et supprimées

Certaines fonctionnalités qui étaient généralement disponibles (GA) ou un aperçu technologique (TP) dans les versions précédentes ont été dépréciées ou supprimées. Les fonctionnalités dépréciées sont toujours incluses dans OpenShift Serverless et continuent d'être prises en charge ; cependant, elles seront supprimées dans une prochaine version de ce produit et ne sont pas recommandées pour les nouveaux déploiements.

Pour la liste la plus récente des principales fonctionnalités dépréciées et supprimées dans OpenShift Serverless, reportez-vous au tableau suivant :

| Fonctionnalité | 1.20 | 1.21 | 1.22 à 1.26 | 1.27 | 1.28 |

|---|---|---|---|---|---|

|

| Déclassé | Déclassé | Supprimé | Supprimé | Supprimé |

|

| Déclassé | Supprimé | Supprimé | Supprimé | Supprimé |

|

Serving and Eventing | - | - | - | Déclassé | Déclassé |

|

| - | - | - | - | Déclassé |

1.4. Notes de version pour Red Hat OpenShift Serverless 1.28

OpenShift Serverless 1.28 est maintenant disponible. Les nouvelles fonctionnalités, les changements et les problèmes connus qui concernent OpenShift Serverless sur OpenShift Container Platform sont inclus dans cette rubrique.

1.4.1. Nouvelles fonctionnalités

- OpenShift Serverless utilise désormais Knative Serving 1.7.

- OpenShift Serverless utilise désormais Knative Eventing 1.7.

- OpenShift Serverless utilise désormais Kourier 1.7.

-

OpenShift Serverless utilise désormais Knative (

kn) CLI 1.7. - OpenShift Serverless utilise désormais l'implémentation du courtier Knative pour Apache Kafka 1.7.

-

Le plug-in

kn funcCLI utilise désormais la version 1.9.1 defunc. - Les moteurs d'exécution Node.js et TypeScript pour OpenShift Serverless Functions sont désormais généralement disponibles (GA).

- Le runtime Python pour OpenShift Serverless Functions est désormais disponible en tant qu'aperçu technologique.

- Le support multi-conteneurs pour Knative Serving est maintenant disponible en tant qu'aperçu technologique. Cette fonctionnalité vous permet d'utiliser un seul service Knative pour déployer un pod multi-conteneurs.

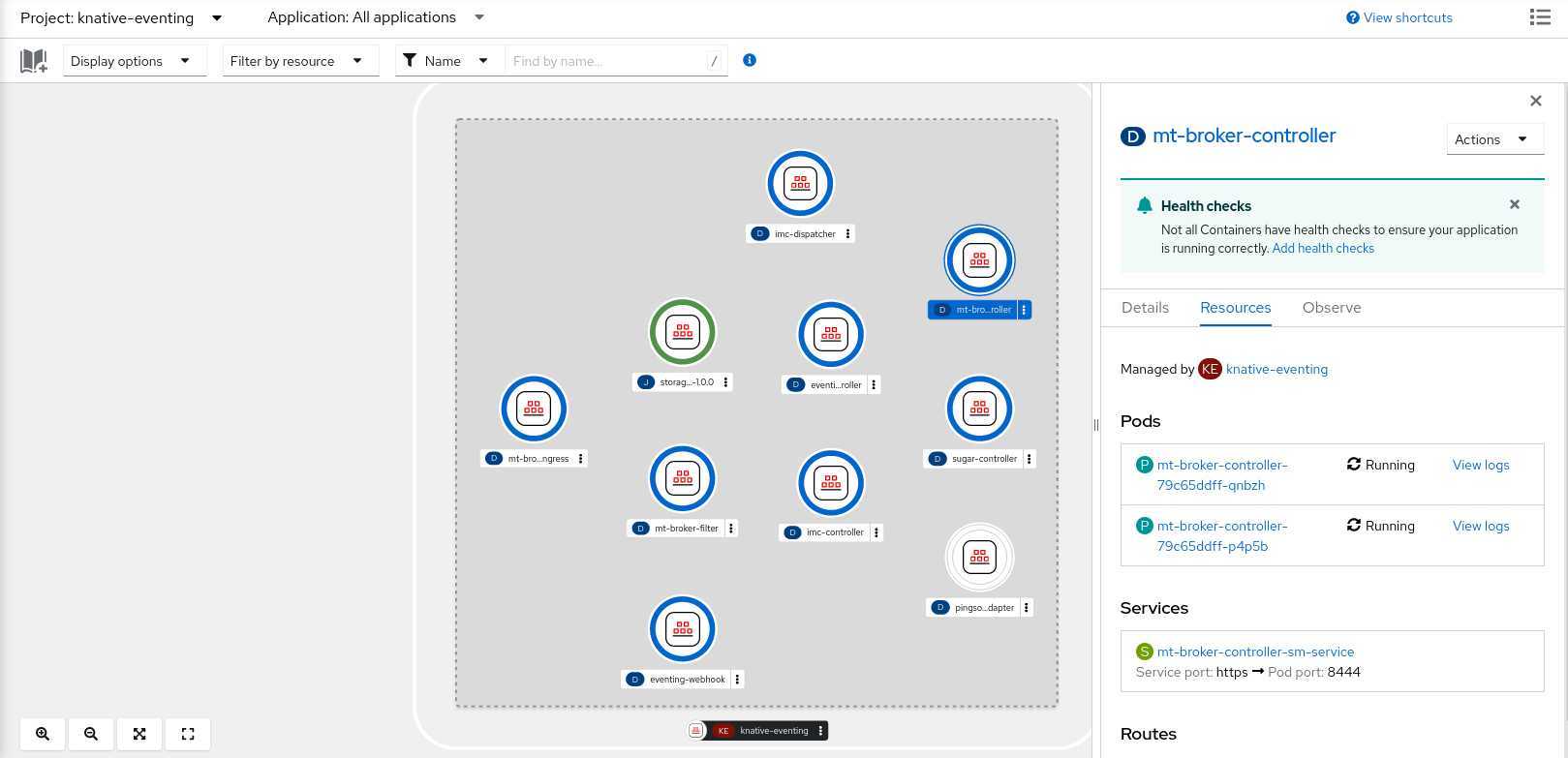

Dans OpenShift Serverless 1.29 ou plus récent, les composants suivants de Knative Eventing seront réduits de deux pods à un seul :

-

imc-controller -

imc-dispatcher -

mt-broker-controller -

mt-broker-filter -

mt-broker-ingress

-

L'annotation

serverless.openshift.io/enable-secret-informer-filteringpour le CR Serving est maintenant obsolète. L'annotation n'est valable que pour Istio, et non pour Kourier.Avec OpenShift Serverless 1.28, l'opérateur OpenShift Serverless permet d'injecter la variable d'environnement

ENABLE_SECRET_INFORMER_FILTERING_BY_CERT_UIDpournet-istioetnet-kourier.Si vous activez le filtrage des secrets, tous vos secrets doivent être étiquetés avec

networking.internal.knative.dev/certificate-uid: "<id>". Sinon, Knative Serving ne les détecte pas, ce qui entraîne des échecs. Vous devez étiqueter à la fois les nouveaux secrets et les secrets existants.Dans l'une des prochaines versions d'OpenShift Serverless, le filtrage des secrets sera activé par défaut. Pour éviter les échecs, étiquetez vos secrets à l'avance.

1.4.2. Problèmes connus

Actuellement, les runtimes pour Python ne sont pas pris en charge pour OpenShift Serverless Functions sur IBM Power, IBM zSystems et IBM® LinuxONE.

Les fonctions Node.js, TypeScript et Quarkus sont prises en charge sur ces architectures.

Sur la plateforme Windows, les fonctions Python ne peuvent pas être construites, exécutées ou déployées localement à l'aide du constructeur Source-to-Image en raison des autorisations du fichier

app.sh.Pour contourner ce problème, utilisez le sous-système Windows pour Linux.

1.5. Notes de version pour Red Hat OpenShift Serverless 1.27

OpenShift Serverless 1.27 est maintenant disponible. Les nouvelles fonctionnalités, les changements et les problèmes connus qui concernent OpenShift Serverless sur OpenShift Container Platform sont inclus dans cette rubrique.

OpenShift Serverless 1.26 est la première version entièrement supportée par OpenShift Container Platform 4.12. OpenShift Serverless 1.25 et les versions antérieures ne se déploient pas sur OpenShift Container Platform 4.12.

Pour cette raison, avant de mettre à niveau OpenShift Container Platform vers la version 4.12, il faut d'abord mettre à niveau OpenShift Serverless vers la version 1.26 ou 1.27.

1.5.1. Nouvelles fonctionnalités

- OpenShift Serverless utilise désormais Knative Serving 1.6.

- OpenShift Serverless utilise désormais Knative Eventing 1.6.

- OpenShift Serverless utilise désormais Kourier 1.6.

-

OpenShift Serverless utilise désormais Knative (

kn) CLI 1.6. - OpenShift Serverless utilise désormais Knative Kafka 1.6.

-

Le plug-in CLI

kn funcutilise désormaisfunc1.8.1. - Les courtiers à espace de nommage sont désormais disponibles en tant qu'aperçu technologique. Ces courtiers peuvent être utilisés, par exemple, pour mettre en œuvre des politiques de contrôle d'accès basées sur les rôles (RBAC).

-

KafkaSinkutilise désormais par défaut le mode de contenu binaireCloudEvent. Le mode de contenu binaire est plus efficace que le mode structuré car il utilise des en-têtes dans son corps au lieu d'unCloudEvent. Par exemple, pour le protocole HTTP, il utilise les en-têtes HTTP. - Vous pouvez désormais utiliser le framework gRPC sur le protocole HTTP/2 pour le trafic externe en utilisant OpenShift Route sur OpenShift Container Platform 4.10 et plus. Cela améliore l'efficacité et la vitesse des communications entre le client et le serveur.

-

La version de l'API

v1alpha1des CRDs Knative Operator Serving et Eventings est obsolète dans la version 1.27. Elle sera supprimée dans les versions futures. Red Hat recommande fortement d'utiliser la versionv1beta1à la place. Cela n'affecte pas les installations existantes, car les CRD sont mis à jour automatiquement lors de la mise à niveau du Serverless Operator. - La fonction de délai de livraison est désormais activée par défaut. Elle vous permet de spécifier le délai d'attente pour chaque requête HTTP envoyée. Cette fonctionnalité reste un aperçu technologique.

1.5.2. Problèmes corrigés

-

Auparavant, les services Knative ne passaient pas toujours à l'état

Ready, signalant qu'ils attendaient que l'équilibreur de charge soit prêt. Ce problème a été corrigé.

1.5.3. Problèmes connus

-

L'intégration d'OpenShift Serverless avec Red Hat OpenShift Service Mesh fait en sorte que le pod

net-kouriermanque de mémoire au démarrage lorsque trop de secrets sont présents sur le cluster. Les courtiers à espace de noms peuvent laisser

ClusterRoleBindingsdans l'espace de noms de l'utilisateur même après la suppression des courtiers à espace de noms.Si cela se produit, supprimez le site

ClusterRoleBindingnommérbac-proxy-reviews-prom-rb-knative-kafka-broker-data-plane-{{.Namespace}}dans l'espace de noms de l'utilisateur.Si vous utilisez

net-istiopour Ingress et activez mTLS via SMCP en utilisantsecurity.dataPlane.mtls: true, Service Mesh déploieDestinationRulespour l'hôte*.local, ce qui n'autorise pasDomainMappingpour OpenShift Serverless.Pour contourner ce problème, activez mTLS en déployant

PeerAuthenticationau lieu d'utilisersecurity.dataPlane.mtls: true.

1.6. Notes de version pour Red Hat OpenShift Serverless 1.26

OpenShift Serverless 1.26 est maintenant disponible. Les nouvelles fonctionnalités, les changements et les problèmes connus qui concernent OpenShift Serverless sur OpenShift Container Platform sont inclus dans cette rubrique.

1.6.1. Nouvelles fonctionnalités

- OpenShift Serverless Functions with Quarkus est maintenant GA.

- OpenShift Serverless utilise désormais Knative Serving 1.5.

- OpenShift Serverless utilise désormais Knative Eventing 1.5.

- OpenShift Serverless utilise désormais Kourier 1.5.

-

OpenShift Serverless utilise désormais Knative (

kn) CLI 1.5. - OpenShift Serverless utilise désormais Knative Kafka 1.5.

- OpenShift Serverless utilise désormais Knative Operator 1.3.

-

Le plugin CLI

kn funcutilise désormaisfunc1.8.1. - Les réclamations de volumes persistants (PVC) sont désormais des GA. Les PVC fournissent un stockage permanent des données pour vos services Knative.

La nouvelle fonctionnalité des filtres de déclenchement est désormais disponible en avant-première pour les développeurs. Elle permet aux utilisateurs de spécifier un ensemble d'expressions de filtrage, où chaque expression est évaluée comme vraie ou fausse pour chaque événement.

Pour activer les nouveaux filtres de déclenchement, ajoutez l'entrée

new-trigger-filters: enableddans la section du typeKnativeEventingdans la carte de configuration de l'opérateur :Copy to Clipboard Copied! Toggle word wrap Toggle overflow Knative Operator 1.3 ajoute la version mise à jour de

v1beta1de l'API pouroperator.knative.dev.Pour passer de

v1alpha1àv1beta1dans vos cartes de configuration des ressources personnaliséesKnativeServingetKnativeEventing, modifiez la cléapiVersion:Exemple

KnativeServingcarte de configuration des ressources personnaliséesapiVersion: operator.knative.dev/v1beta1 kind: KnativeServing ...

apiVersion: operator.knative.dev/v1beta1 kind: KnativeServing ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple

KnativeEventingcarte de configuration des ressources personnaliséesapiVersion: operator.knative.dev/v1beta1 kind: KnativeEventing ...

apiVersion: operator.knative.dev/v1beta1 kind: KnativeEventing ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6.2. Problèmes corrigés

- Auparavant, le mode FIPS (Federal Information Processing Standards) était désactivé pour le courtier Kafka, la source Kafka et le puits Kafka. Ce problème a été corrigé et le mode FIPS est désormais disponible.

1.6.3. Problèmes connus

Si vous utilisez

net-istiopour Ingress et activez mTLS via SMCP en utilisantsecurity.dataPlane.mtls: true, Service Mesh déploieDestinationRulespour l'hôte*.local, ce qui n'autorise pasDomainMappingpour OpenShift Serverless.Pour contourner ce problème, activez mTLS en déployant

PeerAuthenticationau lieu d'utilisersecurity.dataPlane.mtls: true.

1.7. Notes de version pour Red Hat OpenShift Serverless 1.25.0

OpenShift Serverless 1.25.0 est maintenant disponible. Les nouvelles fonctionnalités, les changements et les problèmes connus qui concernent OpenShift Serverless sur OpenShift Container Platform sont inclus dans cette rubrique.

1.7.1. Nouvelles fonctionnalités

- OpenShift Serverless utilise désormais Knative Serving 1.4.

- OpenShift Serverless utilise désormais Knative Eventing 1.4.

- OpenShift Serverless utilise désormais Kourier 1.4.

-

OpenShift Serverless utilise désormais Knative (

kn) CLI 1.4. - OpenShift Serverless utilise désormais Knative Kafka 1.4.

-

Le plugin CLI

kn funcutilise désormaisfunc1.7.0. - Des plugins d'environnement de développement intégré (IDE) pour la création et le déploiement de fonctions sont désormais disponibles pour Visual Studio Code et IntelliJ.

Knative Kafka broker est maintenant GA. Knative Kafka broker est une implémentation très performante de l'API Knative broker, ciblant directement Apache Kafka.

Il est recommandé de ne pas utiliser le MT-Channel-Broker, mais plutôt le Knative Kafka Broker.

-

Le Knative Kafka sink est maintenant GA. Un

KafkaSinkprend unCloudEventet l'envoie à un sujet Apache Kafka. Les événements peuvent être spécifiés en mode de contenu structuré ou binaire. - L'activation de TLS pour le trafic interne est désormais disponible en tant qu'aperçu technologique.

1.7.2. Problèmes corrigés

- Auparavant, Knative Serving avait un problème où la sonde de préparation échouait si le conteneur était redémarré après un échec de la sonde de durée de vie. Ce problème a été corrigé.

1.7.3. Problèmes connus

- Le mode Federal Information Processing Standards (FIPS) est désactivé pour le courtier Kafka, la source Kafka et le puits Kafka.

-

L'objet

SinkBindingne prend pas en charge les noms de révision personnalisés pour les services. Le pod Knative Serving Controller ajoute un nouvel informateur pour surveiller les secrets dans le cluster. L'informateur inclut les secrets dans le cache, ce qui augmente la consommation de mémoire du pod contrôleur.

Si le module manque de mémoire, vous pouvez contourner le problème en augmentant la limite de mémoire pour le déploiement.

Si vous utilisez

net-istiopour Ingress et activez mTLS via SMCP en utilisantsecurity.dataPlane.mtls: true, Service Mesh déploieDestinationRulespour l'hôte*.local, ce qui n'autorise pasDomainMappingpour OpenShift Serverless.Pour contourner ce problème, activez mTLS en déployant

PeerAuthenticationau lieu d'utilisersecurity.dataPlane.mtls: true.

1.8. Notes de version pour Red Hat OpenShift Serverless 1.24.0

OpenShift Serverless 1.24.0 est maintenant disponible. Les nouvelles fonctionnalités, les changements et les problèmes connus qui concernent OpenShift Serverless sur OpenShift Container Platform sont inclus dans cette rubrique.

1.8.1. Nouvelles fonctionnalités

- OpenShift Serverless utilise désormais Knative Serving 1.3.

- OpenShift Serverless utilise désormais Knative Eventing 1.3.

- OpenShift Serverless utilise désormais Kourier 1.3.

-

OpenShift Serverless utilise désormais Knative

knCLI 1.3. - OpenShift Serverless utilise désormais Knative Kafka 1.3.

-

Le plugin CLI

kn funcutilise désormaisfunc0.24. - La prise en charge des services Knative par les conteneurs Init est désormais disponible de manière générale (GA).

- OpenShift Serverless logic est désormais disponible en tant que Developer Preview. Elle permet de définir des modèles de flux de travail déclaratifs pour gérer les applications sans serveur.

- Vous pouvez désormais utiliser le service de gestion des coûts avec OpenShift Serverless.

1.8.2. Problèmes corrigés

L'intégration d'OpenShift Serverless avec Red Hat OpenShift Service Mesh fait en sorte que le pod

net-istio-controllermanque de mémoire au démarrage lorsque trop de secrets sont présents sur le cluster.Il est désormais possible d'activer le filtrage des secrets, ce qui permet à

net-istio-controllerde ne prendre en compte que les secrets portant une étiquettenetworking.internal.knative.dev/certificate-uid, réduisant ainsi la quantité de mémoire nécessaire.- L'aperçu technologique d'OpenShift Serverless Functions utilise désormais par défaut les Buildpacks Cloud Native pour construire des images de conteneurs.

1.8.3. Problèmes connus

- Le mode Federal Information Processing Standards (FIPS) est désactivé pour le courtier Kafka, la source Kafka et le puits Kafka.

Dans OpenShift Serverless 1.23, le support pour KafkaBindings et le webhook

kafka-bindingont été supprimés. Cependant, unkafkabindings.webhook.kafka.sources.knative.dev MutatingWebhookConfigurationexistant peut subsister, pointant vers le servicekafka-source-webhook, qui n'existe plus.Pour certaines spécifications de KafkaBindings sur le cluster,

kafkabindings.webhook.kafka.sources.knative.dev MutatingWebhookConfigurationpeut être configuré pour transmettre tout événement de création et de mise à jour à diverses ressources, telles que Deployments, Knative Services ou Jobs, par le biais du webhook, qui échouerait alors.Pour contourner ce problème, supprimez manuellement

kafkabindings.webhook.kafka.sources.knative.dev MutatingWebhookConfigurationdu cluster après avoir mis à jour OpenShift Serverless 1.23 :oc delete mutatingwebhookconfiguration kafkabindings.webhook.kafka.sources.knative.dev

$ oc delete mutatingwebhookconfiguration kafkabindings.webhook.kafka.sources.knative.devCopy to Clipboard Copied! Toggle word wrap Toggle overflow Si vous utilisez

net-istiopour Ingress et activez mTLS via SMCP en utilisantsecurity.dataPlane.mtls: true, Service Mesh déploieDestinationRulespour l'hôte*.local, ce qui n'autorise pasDomainMappingpour OpenShift Serverless.Pour contourner ce problème, activez mTLS en déployant

PeerAuthenticationau lieu d'utilisersecurity.dataPlane.mtls: true.

1.9. Notes de version pour Red Hat OpenShift Serverless 1.23.0

OpenShift Serverless 1.23.0 est maintenant disponible. Les nouvelles fonctionnalités, les changements et les problèmes connus qui concernent OpenShift Serverless sur OpenShift Container Platform sont inclus dans cette rubrique.

1.9.1. Nouvelles fonctionnalités

- OpenShift Serverless utilise désormais Knative Serving 1.2.

- OpenShift Serverless utilise désormais Knative Eventing 1.2.

- OpenShift Serverless utilise désormais Kourier 1.2.

-

OpenShift Serverless utilise désormais Knative (

kn) CLI 1.2. - OpenShift Serverless utilise désormais Knative Kafka 1.2.

-

Le plugin CLI

kn funcutilise désormaisfunc0.24. -

Il est désormais possible d'utiliser l'annotation

kafka.eventing.knative.dev/external.topicavec le courtier Kafka. Cette annotation permet d'utiliser un topic existant géré en externe au lieu que le broker crée son propre topic interne. -

Les composants Kafka

kafka-ch-controlleretkafka-webhookn'existent plus. Ils ont été remplacés par le composantkafka-webhook-eventing. - L'aperçu technologique d'OpenShift Serverless Functions utilise désormais Source-to-Image (S2I) par défaut pour construire des images de conteneurs.

1.9.2. Problèmes connus

- Le mode Federal Information Processing Standards (FIPS) est désactivé pour le courtier Kafka, la source Kafka et le puits Kafka.

-

Si vous supprimez un espace de noms qui inclut un courtier Kafka, la suppression du finalisateur de l'espace de noms peut échouer si le secret

auth.secret.ref.namedu courtier est supprimé avant le courtier. L'exécution d'OpenShift Serverless avec un grand nombre de services Knative peut faire en sorte que les pods activateurs Knative s'approchent de leur limite de mémoire par défaut de 600 Mo. Ces pods peuvent être redémarrés si la consommation de mémoire atteint cette limite. Les requêtes et les limites pour le déploiement de l'activateur peuvent être configurées en modifiant la ressource personnalisée

KnativeServing:Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

Si vous utilisez Cloud Native Buildpacks comme stratégie de construction locale pour une fonction,

kn funcn'est pas en mesure de démarrer automatiquement podman ou d'utiliser un tunnel SSH vers un démon distant. Pour résoudre ces problèmes, il faut qu'un démon Docker ou podman soit déjà en cours d'exécution sur l'ordinateur de développement local avant de déployer une fonction. - Les constructions de fonctions sur le cluster échouent actuellement pour les systèmes d'exécution Quarkus et Golang. Elles fonctionnent correctement pour les exécutions Node, Typescript, Python et Springboot.

Si vous utilisez

net-istiopour Ingress et activez mTLS via SMCP en utilisantsecurity.dataPlane.mtls: true, Service Mesh déploieDestinationRulespour l'hôte*.local, ce qui n'autorise pasDomainMappingpour OpenShift Serverless.Pour contourner ce problème, activez mTLS en déployant

PeerAuthenticationau lieu d'utilisersecurity.dataPlane.mtls: true.

1.10. Notes de version pour Red Hat OpenShift Serverless 1.22.0

OpenShift Serverless 1.22.0 est maintenant disponible. Les nouvelles fonctionnalités, les changements et les problèmes connus qui concernent OpenShift Serverless sur OpenShift Container Platform sont inclus dans cette rubrique.

1.10.1. Nouvelles fonctionnalités

- OpenShift Serverless utilise désormais Knative Serving 1.1.

- OpenShift Serverless utilise désormais Knative Eventing 1.1.

- OpenShift Serverless utilise désormais Kourier 1.1.

-

OpenShift Serverless utilise désormais Knative (

kn) CLI 1.1. - OpenShift Serverless utilise désormais Knative Kafka 1.1.

-

Le plugin CLI

kn funcutilise désormaisfunc0.23. - Le support des conteneurs Init pour les services Knative est maintenant disponible en tant qu'aperçu technologique.

- La prise en charge des réclamations de volume persistantes (PVC) pour les services Knative est désormais disponible en tant qu'aperçu technologique.

-

Les espaces de noms des systèmes

knative-serving,knative-serving-ingress,knative-eventingetknative-kafkaont désormais l'étiquetteknative.openshift.io/part-of: "openshift-serverless"par défaut. - Le tableau de bord Knative Eventing - Kafka Broker/Trigger a été ajouté, ce qui permet de visualiser le courtier Kafka et les métriques de déclenchement dans la console web.

- Le tableau de bord Knative Eventing - KafkaSink a été ajouté, ce qui permet de visualiser les métriques de KafkaSink dans la console web.

- Le tableau de bord Knative Eventing - Broker/Trigger s'appelle désormais Knative Eventing - Channel-based Broker/Trigger.

-

Le label

knative.openshift.io/part-of: "openshift-serverless"a remplacé le labelknative.openshift.io/system-namespace. -

Le style de nommage dans les fichiers de configuration YAML de Knative Serving est passé de la casse camel (

ExampleName) au style trait d'union (example-name). À partir de cette version, utilisez la notation de style trait d'union lors de la création ou de l'édition des fichiers de configuration YAML de Knative Serving.

1.10.2. Problèmes connus

- Le mode Federal Information Processing Standards (FIPS) est désactivé pour le courtier Kafka, la source Kafka et le puits Kafka.

1.11. Notes de version pour Red Hat OpenShift Serverless 1.21.0

OpenShift Serverless 1.21.0 est maintenant disponible. Les nouvelles fonctionnalités, les changements et les problèmes connus qui concernent OpenShift Serverless sur OpenShift Container Platform sont inclus dans cette rubrique.

1.11.1. Nouvelles fonctionnalités

- OpenShift Serverless utilise désormais Knative Serving 1.0

- OpenShift Serverless utilise désormais Knative Eventing 1.0.

- OpenShift Serverless utilise désormais Kourier 1.0.

-

OpenShift Serverless utilise désormais Knative (

kn) CLI 1.0. - OpenShift Serverless utilise désormais Knative Kafka 1.0.

-

Le plugin CLI

kn funcutilise désormaisfunc0.21. - Le puits Kafka est maintenant disponible en tant qu'aperçu technologique.

-

Le projet open source Knative a commencé à déprécier les clés de configuration à base de camel en faveur de l'utilisation cohérente de clés à base de kebab. Par conséquent, la clé

defaultExternalScheme, précédemment mentionnée dans les notes de version 1.18.0 d'OpenShift Serverless, est maintenant obsolète et remplacée par la clédefault-external-scheme. Les instructions d'utilisation de la clé restent les mêmes.

1.11.2. Problèmes corrigés

-

Dans OpenShift Serverless 1.20.0, il y avait un problème de livraison d'événement affectant l'utilisation de

kn event sendpour envoyer des événements à un service. Ce problème est maintenant corrigé. -

Dans OpenShift Serverless 1.20.0 (

func0.20), les fonctions TypeScript créées avec le modèlehttpne parvenaient pas à se déployer sur le cluster. Ce problème est maintenant corrigé. -

Dans OpenShift Serverless 1.20.0 (

func0.20), le déploiement d'une fonction utilisant le registregcr.ioéchouait avec une erreur. Ce problème est maintenant corrigé. -

Dans OpenShift Serverless 1.20.0 (

func0.20), la création d'un répertoire de projet de fonction Springboot avec la commandekn func createet l'exécution de la commandekn func buildont échoué avec un message d'erreur. Ce problème est maintenant corrigé. -

Dans OpenShift Serverless 1.19.0 (

func0.19), certains runtimes étaient incapables de construire une fonction en utilisant podman. Ce problème est maintenant corrigé.

1.11.3. Problèmes connus

Actuellement, le contrôleur de mappage de domaine ne peut pas traiter l'URI d'un courtier qui contient un chemin qui n'est actuellement pas pris en charge.

Cela signifie que si vous souhaitez utiliser une ressource personnalisée (CR)

DomainMappingpour mapper un domaine personnalisé à un courtier, vous devez configurer la CRDomainMappingavec le service d'entrée du courtier et ajouter le chemin d'accès exact du courtier au domaine personnalisé :Exemple

DomainMappingCRCopy to Clipboard Copied! Toggle word wrap Toggle overflow L'URI du courtier est alors

<domain-name>/<broker-namespace>/<broker-name>.

1.12. Notes de version pour Red Hat OpenShift Serverless 1.20.0

OpenShift Serverless 1.20.0 est maintenant disponible. Les nouvelles fonctionnalités, les changements et les problèmes connus qui concernent OpenShift Serverless sur OpenShift Container Platform sont inclus dans cette rubrique.

1.12.1. Nouvelles fonctionnalités

- OpenShift Serverless utilise désormais Knative Serving 0.26.

- OpenShift Serverless utilise désormais Knative Eventing 0.26.

- OpenShift Serverless utilise désormais Kourier 0.26.

-

OpenShift Serverless utilise désormais Knative (

kn) CLI 0.26. - OpenShift Serverless utilise désormais Knative Kafka 0.26.

-

Le plugin CLI

kn funcutilise désormaisfunc0.20. Le courtier Kafka est désormais disponible en tant qu'aperçu technologique.

ImportantLe courtier Kafka, qui est actuellement en avant-première technologique, n'est pas pris en charge par FIPS.

-

Le plugin

kn eventest désormais disponible en tant qu'aperçu technologique. -

Les drapeaux

--min-scaleet--max-scalede la commandekn service createsont obsolètes. Utilisez plutôt les drapeaux--scale-minet--scale-max.

1.12.2. Problèmes connus

OpenShift Serverless déploie les services Knative avec une adresse par défaut qui utilise HTTPS. Lors de l'envoi d'un événement à une ressource à l'intérieur du cluster, l'expéditeur n'a pas l'autorité de certification (CA) du cluster configurée. Cela entraîne l'échec de la livraison de l'événement, à moins que le cluster n'utilise des certificats globalement acceptés.

Par exemple, la livraison d'un événement à une adresse accessible au public fonctionne :

kn event send --to-url https://ce-api.foo.example.com/

$ kn event send --to-url https://ce-api.foo.example.com/Copy to Clipboard Copied! Toggle word wrap Toggle overflow En revanche, cette livraison échoue si le service utilise une adresse publique avec un certificat HTTPS délivré par une autorité de certification personnalisée :

kn event send --to Service:serving.knative.dev/v1:event-display

$ kn event send --to Service:serving.knative.dev/v1:event-displayCopy to Clipboard Copied! Toggle word wrap Toggle overflow L'envoi d'un événement à d'autres objets adressables, tels que les courtiers ou les canaux, n'est pas concerné par ce problème et fonctionne comme prévu.

- Le courtier Kafka ne fonctionne pas actuellement sur un cluster avec le mode Federal Information Processing Standards (FIPS) activé.

Si vous créez un répertoire de projet de fonction Springboot avec la commande

kn func create, l'exécution ultérieure de la commandekn func buildéchoue avec ce message d'erreur :[analyzer] no stack metadata found at path '' [analyzer] ERROR: failed to : set API for buildpack 'paketo-buildpacks/ca-certificates@3.0.2': buildpack API version '0.7' is incompatible with the lifecycle

[analyzer] no stack metadata found at path '' [analyzer] ERROR: failed to : set API for buildpack 'paketo-buildpacks/ca-certificates@3.0.2': buildpack API version '0.7' is incompatible with the lifecycleCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pour contourner le problème, vous pouvez remplacer la propriété

builderpargcr.io/paketo-buildpacks/builder:basedans le fichier de configuration de la fonctionfunc.yaml.Le déploiement d'une fonction à l'aide du registre

gcr.ioéchoue avec ce message d'erreur :Error: failed to get credentials: failed to verify credentials: status code: 404

Error: failed to get credentials: failed to verify credentials: status code: 404Copy to Clipboard Copied! Toggle word wrap Toggle overflow Pour contourner le problème, utilisez un registre différent de celui de

gcr.io, tel quequay.iooudocker.io.Les fonctions TypeScript créées avec le modèle

httpne se déploient pas sur le cluster.Pour contourner le problème, remplacez la section suivante dans le fichier

func.yaml:buildEnvs: []

buildEnvs: []Copy to Clipboard Copied! Toggle word wrap Toggle overflow avec ceci :

buildEnvs: - name: BP_NODE_RUN_SCRIPTS value: build

buildEnvs: - name: BP_NODE_RUN_SCRIPTS value: buildCopy to Clipboard Copied! Toggle word wrap Toggle overflow Dans

funcversion 0.20, certains runtimes peuvent être incapables de construire une fonction en utilisant podman. Vous pouvez voir un message d'erreur similaire au suivant :ERROR: failed to image: error during connect: Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.40/info": EOF

ERROR: failed to image: error during connect: Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.40/info": EOFCopy to Clipboard Copied! Toggle word wrap Toggle overflow La solution suivante permet de résoudre ce problème :

Mettez à jour le service podman en ajoutant

--time=0à la définition du serviceExecStart:Exemple de configuration de service

ExecStart=/usr/bin/podman $LOGGING system service --time=0

ExecStart=/usr/bin/podman $LOGGING system service --time=0Copy to Clipboard Copied! Toggle word wrap Toggle overflow Redémarrez le service podman en exécutant les commandes suivantes :

systemctl --user daemon-reload

$ systemctl --user daemon-reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl restart --user podman.socket

$ systemctl restart --user podman.socketCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Vous pouvez également exposer l'API podman en utilisant TCP :

podman system service --time=0 tcp:127.0.0.1:5534 & export DOCKER_HOST=tcp://127.0.0.1:5534

$ podman system service --time=0 tcp:127.0.0.1:5534 & export DOCKER_HOST=tcp://127.0.0.1:5534Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.13. Notes de version pour Red Hat OpenShift Serverless 1.19.0

OpenShift Serverless 1.19.0 est maintenant disponible. Les nouvelles fonctionnalités, les changements et les problèmes connus qui concernent OpenShift Serverless sur OpenShift Container Platform sont inclus dans cette rubrique.

1.13.1. Nouvelles fonctionnalités

- OpenShift Serverless utilise désormais Knative Serving 0.25.

- OpenShift Serverless utilise désormais Knative Eventing 0.25.

- OpenShift Serverless utilise désormais Kourier 0.25.

-

OpenShift Serverless utilise désormais Knative (

kn) CLI 0.25. - OpenShift Serverless utilise désormais Knative Kafka 0.25.

-

Le plugin CLI

kn funcutilise désormaisfunc0.19. -

L'API

KafkaBindingest obsolète dans OpenShift Serverless 1.19.0 et sera supprimée dans une prochaine version. - La redirection HTTPS est maintenant supportée et peut être configurée soit globalement pour un cluster, soit pour chaque service Knative.

1.13.2. Problèmes corrigés

- Dans les versions précédentes, le répartiteur du canal Kafka n'attendait que le succès du commit local avant de répondre, ce qui pouvait entraîner la perte d'événements en cas de défaillance d'un nœud Apache Kafka. Le répartiteur du canal Kafka attend désormais que toutes les répliques synchronisées s'engagent avant de répondre.

1.13.3. Problèmes connus

Dans

funcversion 0.19, certains runtimes peuvent être incapables de construire une fonction en utilisant podman. Vous pouvez voir un message d'erreur similaire au suivant :ERROR: failed to image: error during connect: Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.40/info": EOF

ERROR: failed to image: error during connect: Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.40/info": EOFCopy to Clipboard Copied! Toggle word wrap Toggle overflow La solution suivante permet de résoudre ce problème :

Mettez à jour le service podman en ajoutant

--time=0à la définition du serviceExecStart:Exemple de configuration de service

ExecStart=/usr/bin/podman $LOGGING system service --time=0

ExecStart=/usr/bin/podman $LOGGING system service --time=0Copy to Clipboard Copied! Toggle word wrap Toggle overflow Redémarrez le service podman en exécutant les commandes suivantes :

systemctl --user daemon-reload

$ systemctl --user daemon-reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl restart --user podman.socket

$ systemctl restart --user podman.socketCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Vous pouvez également exposer l'API podman en utilisant TCP :

podman system service --time=0 tcp:127.0.0.1:5534 & export DOCKER_HOST=tcp://127.0.0.1:5534

$ podman system service --time=0 tcp:127.0.0.1:5534 & export DOCKER_HOST=tcp://127.0.0.1:5534Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.14. Notes de version pour Red Hat OpenShift Serverless 1.18.0

OpenShift Serverless 1.18.0 est maintenant disponible. Les nouvelles fonctionnalités, les changements et les problèmes connus qui concernent OpenShift Serverless sur OpenShift Container Platform sont inclus dans cette rubrique.

1.14.1. Nouvelles fonctionnalités

- OpenShift Serverless utilise désormais Knative Serving 0.24.0.

- OpenShift Serverless utilise désormais Knative Eventing 0.24.0.

- OpenShift Serverless utilise désormais Kourier 0.24.0.

-

OpenShift Serverless utilise maintenant Knative (

kn) CLI 0.24.0. - OpenShift Serverless utilise désormais Knative Kafka 0.24.7.

-

Le plugin CLI

kn funcutilise désormaisfunc0.18.0. Dans la prochaine version OpenShift Serverless 1.19.0, le schéma d'URL des routes externes sera par défaut HTTPS pour une sécurité accrue.

Si vous ne souhaitez pas que cette modification s'applique à vos charges de travail, vous pouvez remplacer le paramètre par défaut avant de passer à la version 1.19.0, en ajoutant le fichier YAML suivant à votre ressource personnalisée (CR)

KnativeServing:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Si vous voulez que le changement s'applique déjà à la version 1.18.0, ajoutez le YAML suivant :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Dans la prochaine version OpenShift Serverless 1.19.0, le type de service par défaut par lequel la passerelle Kourier est exposée sera

ClusterIPet nonLoadBalancer.Si vous ne souhaitez pas que cette modification s'applique à vos charges de travail, vous pouvez remplacer le paramètre par défaut avant la mise à niveau vers la version 1.19.0, en ajoutant le fichier YAML suivant à votre ressource personnalisée (CR)

KnativeServing:Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

Vous pouvez désormais utiliser les volumes

emptyDiravec OpenShift Serverless. Voir la documentation OpenShift Serverless sur Knative Serving pour plus de détails. -

Les modèles Rust sont désormais disponibles lorsque vous créez une fonction à l'aide de

kn func.

1.14.2. Problèmes corrigés

- La version précédente 1.4 de Camel-K n'était pas compatible avec OpenShift Serverless 1.17.0. Le problème dans Camel-K a été corrigé, et la version 1.4.1 de Camel-K peut être utilisée avec OpenShift Serverless 1.17.0.

Auparavant, si vous créiez un nouvel abonnement pour un canal Kafka ou une nouvelle source Kafka, il était possible que le plan de données Kafka ne soit pas prêt à distribuer les messages après que l'abonnement ou le puits nouvellement créé ait signalé un statut prêt.

Par conséquent, les messages envoyés pendant la période où le plan de données n'indiquait pas qu'il était prêt peuvent ne pas avoir été transmis à l'abonné ou au destinataire.

Dans OpenShift Serverless 1.18.0, le problème est corrigé et les messages initiaux ne sont plus perdus. Pour plus d'informations sur ce problème, voir l'article #6343981 de la base de connaissances.

1.14.3. Problèmes connus

Les anciennes versions du CLI Knative

knpeuvent utiliser d'anciennes versions des API Knative Serving et Knative Eventing. Par exemple, la version 0.23.2 du CLIknutilise la version de l'APIv1alpha1.D'autre part, les nouvelles versions d'OpenShift Serverless peuvent ne plus prendre en charge les anciennes versions de l'API. Par exemple, OpenShift Serverless 1.18.0 ne prend plus en charge la version

v1alpha1de l'APIkafkasources.sources.knative.dev.Par conséquent, l'utilisation d'une ancienne version de la CLI Knative

knavec une version plus récente d'OpenShift Serverless peut produire une erreur parce queknne peut pas trouver l'API obsolète. Par exemple, la version 0.23.2 du CLIknne fonctionne pas avec OpenShift Serverless 1.18.0.Pour éviter tout problème, utilisez la dernière version de

knCLI disponible pour votre version d'OpenShift Serverless. Pour OpenShift Serverless 1.18.0, utilisez KnativeknCLI 0.24.0.

Chapitre 2. À propos de Serverless

2.1. Aperçu d'OpenShift Serverless

OpenShift Serverless fournit des blocs de construction natifs de Kubernetes qui permettent aux développeurs de créer et de déployer des applications sans serveur et axées sur les événements sur OpenShift Container Platform. OpenShift Serverless est basé sur le projet open source Knative, qui assure la portabilité et la cohérence pour les environnements hybrides et multicloud en permettant une plateforme serverless de niveau entreprise.

Parce qu'OpenShift Serverless est publié à une cadence différente de celle d'OpenShift Container Platform, la documentation d'OpenShift Serverless ne maintient pas de jeux de documentation distincts pour les versions mineures du produit. La documentation actuelle s'applique à toutes les versions d'OpenShift Serverless actuellement prises en charge, à moins que des limitations spécifiques à une version ne soient indiquées dans un sujet particulier ou pour une fonctionnalité particulière.

Pour plus d'informations sur le cycle de vie d'OpenShift Serverless et les plateformes prises en charge, consultez la Politique relative au cycle de vie des plateformes.

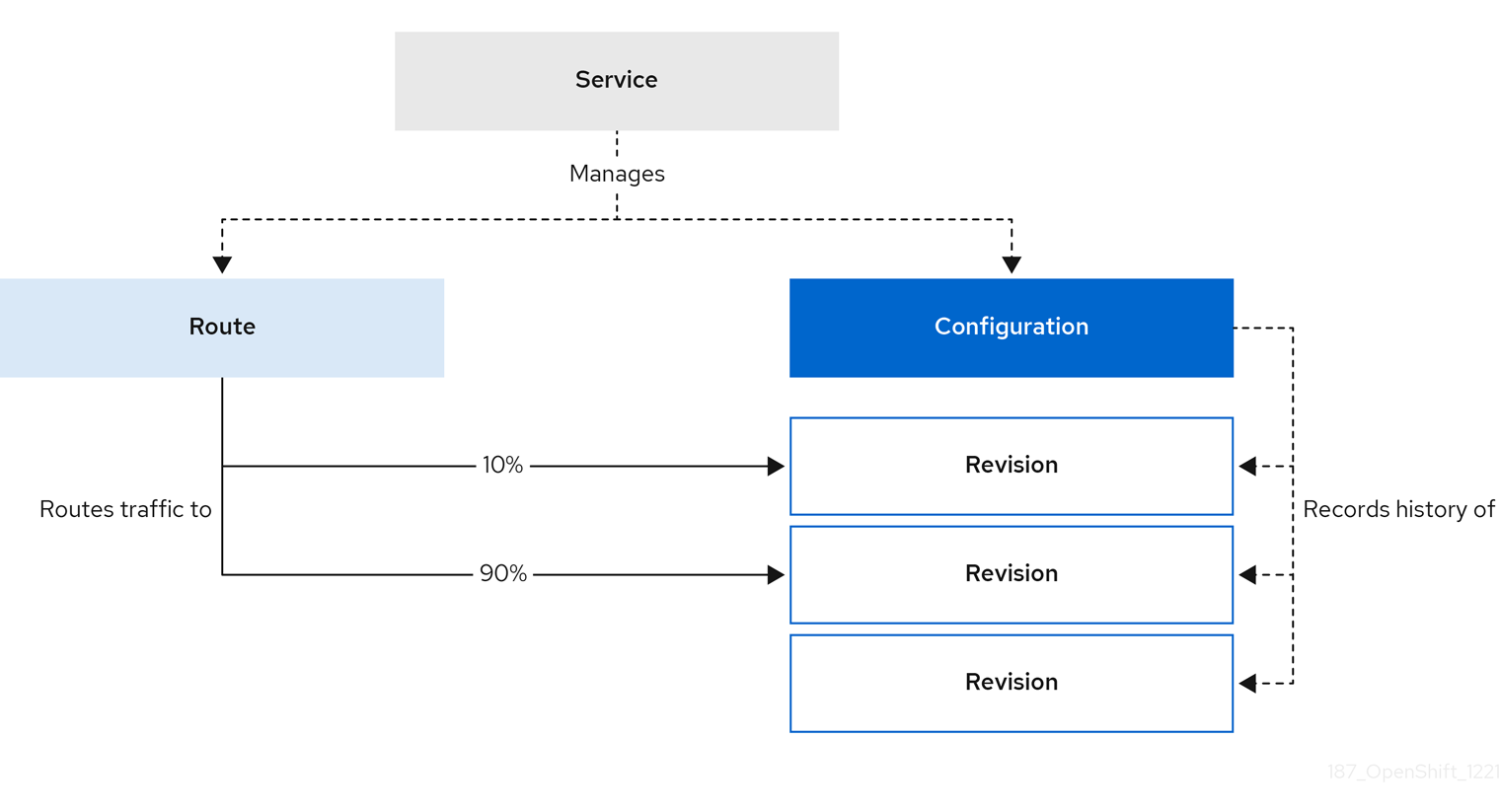

2.2. Servir Knative

Knative Serving soutient les développeurs qui souhaitent créer, déployer et gérer des applications cloud-natives. Il fournit un ensemble d'objets en tant que définitions de ressources personnalisées Kubernetes (CRD) qui définissent et contrôlent le comportement des charges de travail sans serveur sur un cluster OpenShift Container Platform.

Les développeurs utilisent ces CRD pour créer des instances de ressources personnalisées (CR) qui peuvent être utilisées comme blocs de construction pour répondre à des cas d'utilisation complexes. Par exemple :

- Déployer rapidement des conteneurs sans serveur.

- Mise à l'échelle automatique des pods.

2.2.1. Ressources de service Knative

- Service

-

Le CRD

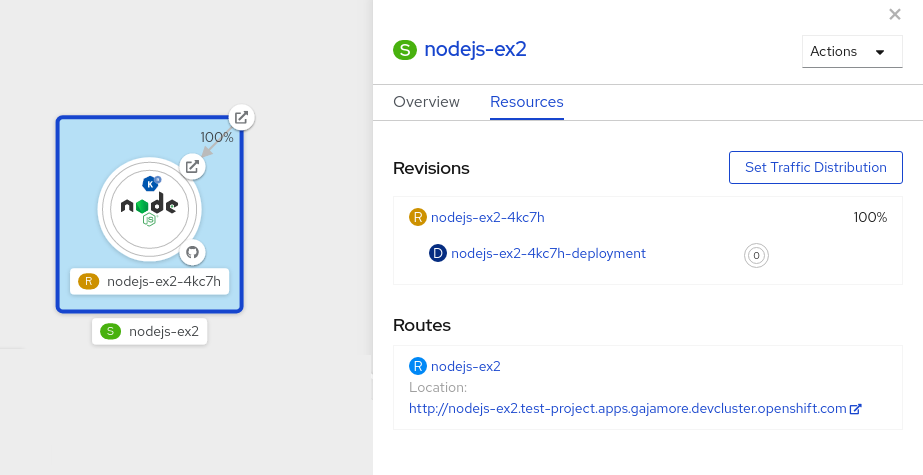

service.serving.knative.devgère automatiquement le cycle de vie de votre charge de travail pour s'assurer que l'application est déployée et accessible via le réseau. Il crée une route, une configuration et une nouvelle révision pour chaque changement apporté à un service créé par l'utilisateur ou à une ressource personnalisée. La plupart des interactions des développeurs dans Knative sont effectuées en modifiant les services. - Révision

-

Le CRD

revision.serving.knative.devest un instantané du code et de la configuration pour chaque modification apportée à la charge de travail. Les révisions sont des objets immuables et peuvent être conservées aussi longtemps que nécessaire. - Itinéraire

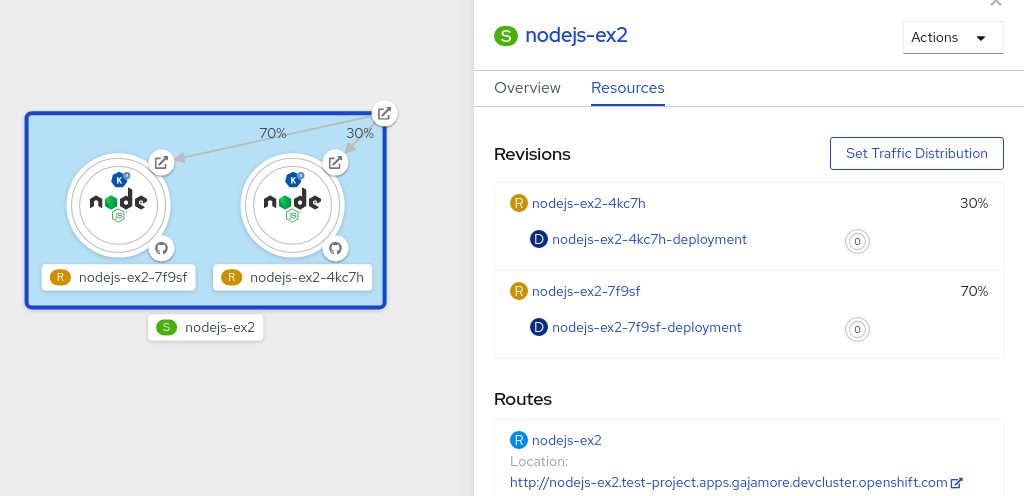

-

Le CRD

route.serving.knative.devétablit une correspondance entre un point d'extrémité du réseau et une ou plusieurs révisions. Vous pouvez gérer le trafic de plusieurs manières, y compris le trafic fractionné et les itinéraires nommés. - Configuration

-

Le CRD

configuration.serving.knative.devmaintient l'état souhaité pour votre déploiement. Il fournit une séparation nette entre le code et la configuration. La modification d'une configuration crée une nouvelle révision.

2.3. Concours complet d'équitation

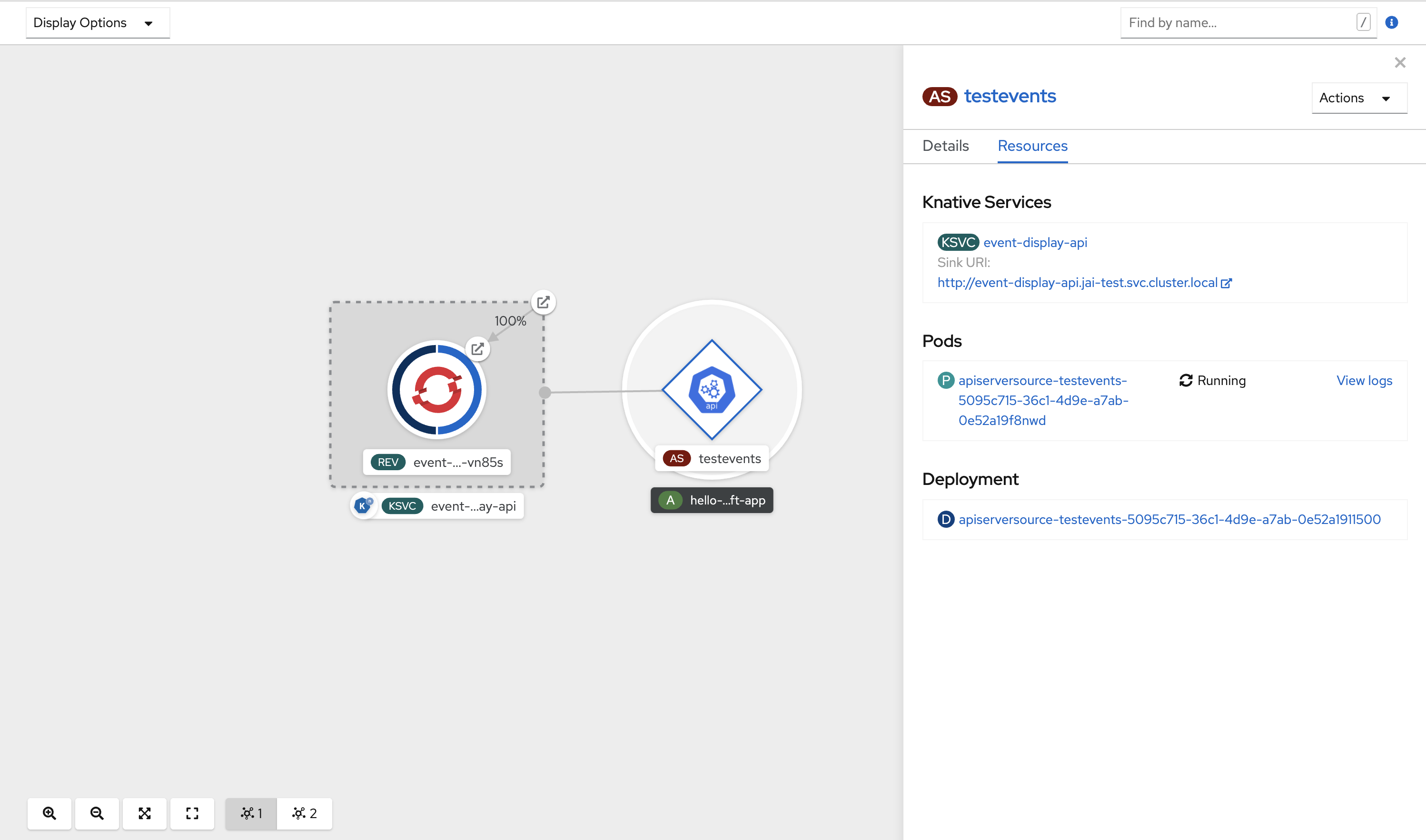

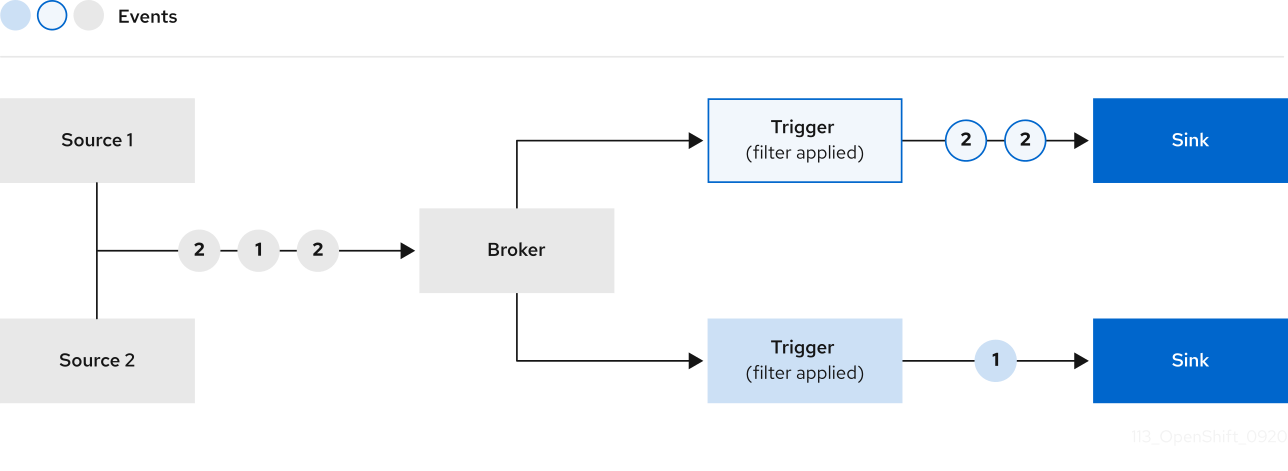

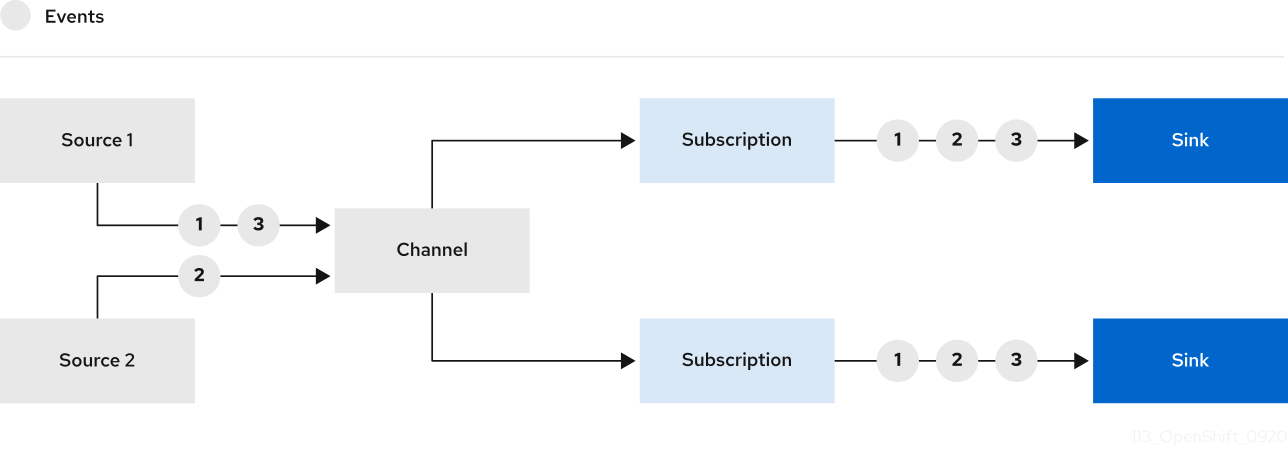

Knative Eventing sur OpenShift Container Platform permet aux développeurs d'utiliser une architecture pilotée par les événements avec des applications sans serveur. Une architecture pilotée par les événements est basée sur le concept de relations découplées entre les producteurs et les consommateurs d'événements.

Les producteurs d'événements créent des événements, et les événements sinks, ou consommateurs, reçoivent des événements. Knative Eventing utilise des requêtes HTTP POST standard pour envoyer et recevoir des événements entre les producteurs et les récepteurs d'événements. Ces événements sont conformes aux spécifications CloudEvents, qui permettent de créer, d'analyser, d'envoyer et de recevoir des événements dans n'importe quel langage de programmation.

Knative Eventing prend en charge les cas d'utilisation suivants :

- Publier un événement sans créer de consommateur

- Vous pouvez envoyer des événements à un courtier sous la forme d'un HTTP POST et utiliser la liaison pour découpler la configuration de destination de votre application qui produit les événements.

- Consommer un événement sans créer d'éditeur

- Vous pouvez utiliser un déclencheur pour consommer des événements à partir d'un courtier en fonction des attributs de l'événement. L'application reçoit les événements sous forme de HTTP POST.

Pour permettre la livraison à plusieurs types de puits, Knative Eventing définit les interfaces génériques suivantes qui peuvent être mises en œuvre par plusieurs ressources Kubernetes :

- Ressources adressables

-

Capable de recevoir et d'accuser réception d'un événement transmis par HTTP à une adresse définie dans le champ

status.address.urlde l'événement. La ressource KubernetesServicesatisfait également à l'interface adressable. - Ressources appelables

-

Capable de recevoir un événement transmis par HTTP et de le transformer, en renvoyant

0ou1nouveaux événements dans la charge utile de la réponse HTTP. Ces événements renvoyés peuvent être traités de la même manière que les événements provenant d'une source externe.

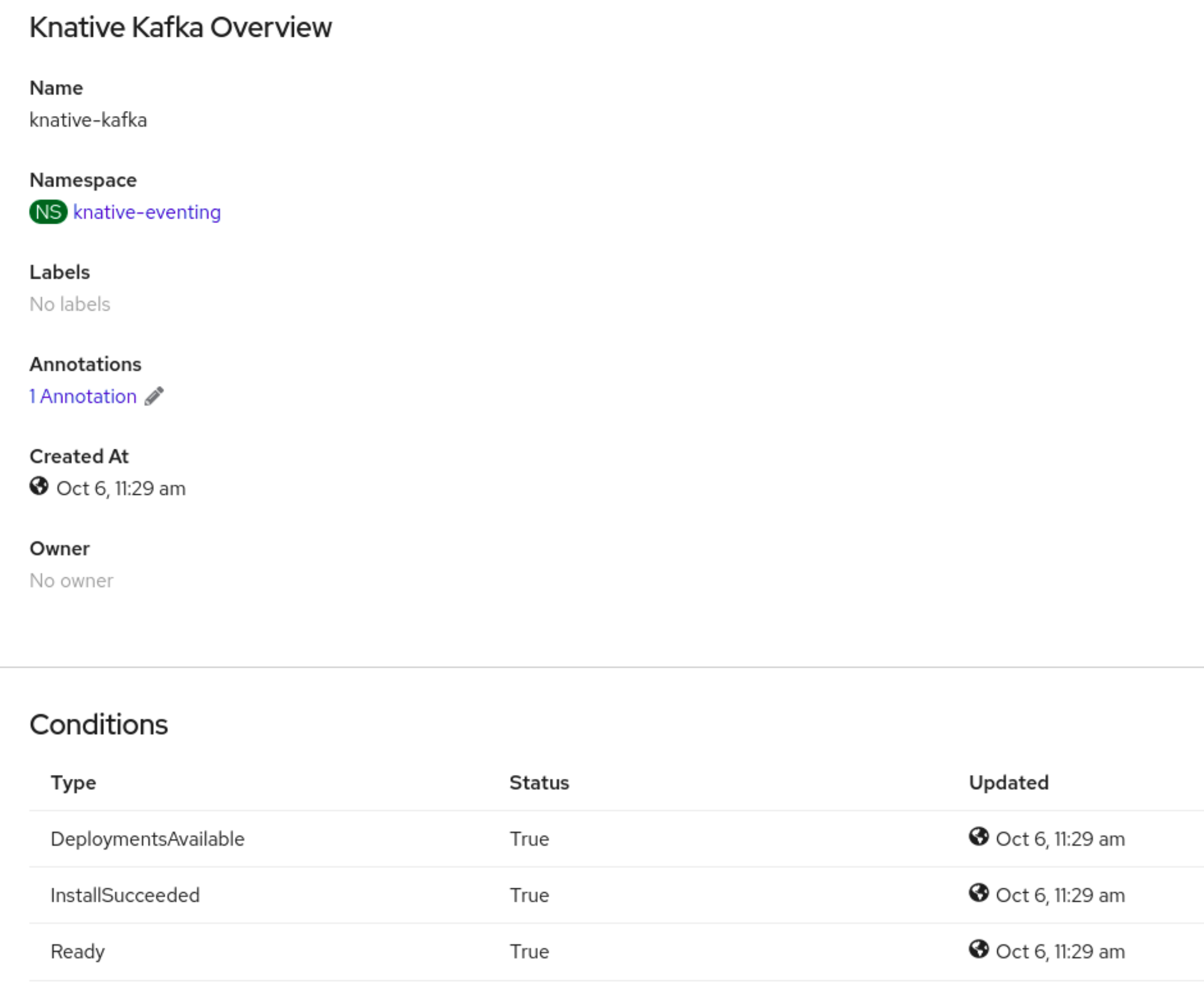

2.3.1. Utiliser le courtier Knative pour Apache Kafka

L'implémentation du courtier Knative pour Apache Kafka fournit des options d'intégration vous permettant d'utiliser les versions prises en charge de la plateforme de streaming de messages Apache Kafka avec OpenShift Serverless. Kafka fournit des options pour la source d'événement, le canal, le courtier et les capacités de puits d'événement.

L'implémentation du courtier Knative pour Apache Kafka n'est pas actuellement prise en charge pour les systèmes IBM zSystems et IBM Power.

Le courtier Knative pour Apache Kafka offre des options supplémentaires, telles que :

- Source Kafka

- Canal Kafka

- Courtier Kafka

- Puits Kafka

2.4. À propos d'OpenShift Serverless Functions

OpenShift Serverless Functions permet aux développeurs de créer et de déployer des fonctions sans état et pilotées par des événements en tant que service Knative sur OpenShift Container Platform. Le CLI kn func est fourni en tant que plugin pour le CLI Knative kn. Vous pouvez utiliser la CLI kn func pour créer, construire et déployer l'image du conteneur en tant que service Knative sur le cluster.

2.4.1. Temps d'exécution inclus

OpenShift Serverless Functions fournit des modèles qui peuvent être utilisés pour créer des fonctions de base pour les runtimes suivants :

2.4.2. Prochaines étapes

- Commencer avec les fonctions.

Chapitre 3. Installation de Serverless

3.1. Préparer l'installation d'OpenShift Serverless

Lisez les informations suivantes sur les configurations prises en charge et les prérequis avant d'installer OpenShift Serverless.

- OpenShift Serverless est pris en charge pour une installation dans un environnement réseau restreint.

- OpenShift Serverless ne peut actuellement pas être utilisé dans une configuration multi-tenant sur un seul cluster.

3.1.1. Configurations prises en charge

L'ensemble des fonctionnalités, configurations et intégrations prises en charge pour OpenShift Serverless, versions actuelles et antérieures, est disponible sur la page Configurations prises en charge.

3.1.2. Évolutivité et performance

OpenShift Serverless a été testé avec une configuration de 3 nœuds principaux et 3 nœuds de travail, qui disposent chacun de 64 CPU, 457 Go de mémoire et 394 Go de stockage.

Le nombre maximal de services Knative pouvant être créés à l'aide de cette configuration est de 3 000. Cela correspond à la limite de 10 000 services Kubernetes de OpenShift Container Platform, puisque 1 service Knative crée 3 services Kubernetes.

Le temps de réponse moyen à partir de zéro était d'environ 3,4 secondes, avec un temps de réponse maximum de 8 secondes, et un 99,9ème percentile de 4,5 secondes pour une application Quarkus simple. Ces temps peuvent varier en fonction de l'application et de sa durée d'exécution.

3.1.3. Définition des exigences en matière de taille des grappes

Pour installer et utiliser OpenShift Serverless, le cluster OpenShift Container Platform doit être correctement dimensionné.

Les exigences suivantes ne concernent que le pool de machines de travail du cluster OpenShift Container Platform. Les nœuds du plan de contrôle ne sont pas utilisés pour l'ordonnancement général et ne sont pas pris en compte dans les exigences.

Le minimum requis pour utiliser OpenShift Serverless est un cluster avec 10 CPUs et 40GB de mémoire. Par défaut, chaque pod demande ~400m de CPU, les exigences minimales sont donc basées sur cette valeur.

La taille totale requise pour exécuter OpenShift Serverless dépend des composants installés et des applications déployées, et peut varier en fonction de votre déploiement.

3.1.4. Mise à l'échelle de votre cluster à l'aide d'ensembles de machines de calcul

Vous pouvez utiliser l'API d'OpenShift Container Platform MachineSet pour augmenter manuellement la taille de votre cluster. Les exigences minimales signifient généralement que vous devez augmenter l'un des ensembles de machines de calcul par défaut de deux machines supplémentaires. Voir Mise à l'échelle manuelle d'un ensemble de machines de calcul.

3.1.4.1. Exigences supplémentaires pour les cas d'utilisation avancés

Pour des cas d'utilisation plus avancés tels que le logging ou le metering sur OpenShift Container Platform, vous devez déployer plus de ressources. Les exigences recommandées pour de tels cas d'utilisation sont 24 CPU et 96 Go de mémoire.

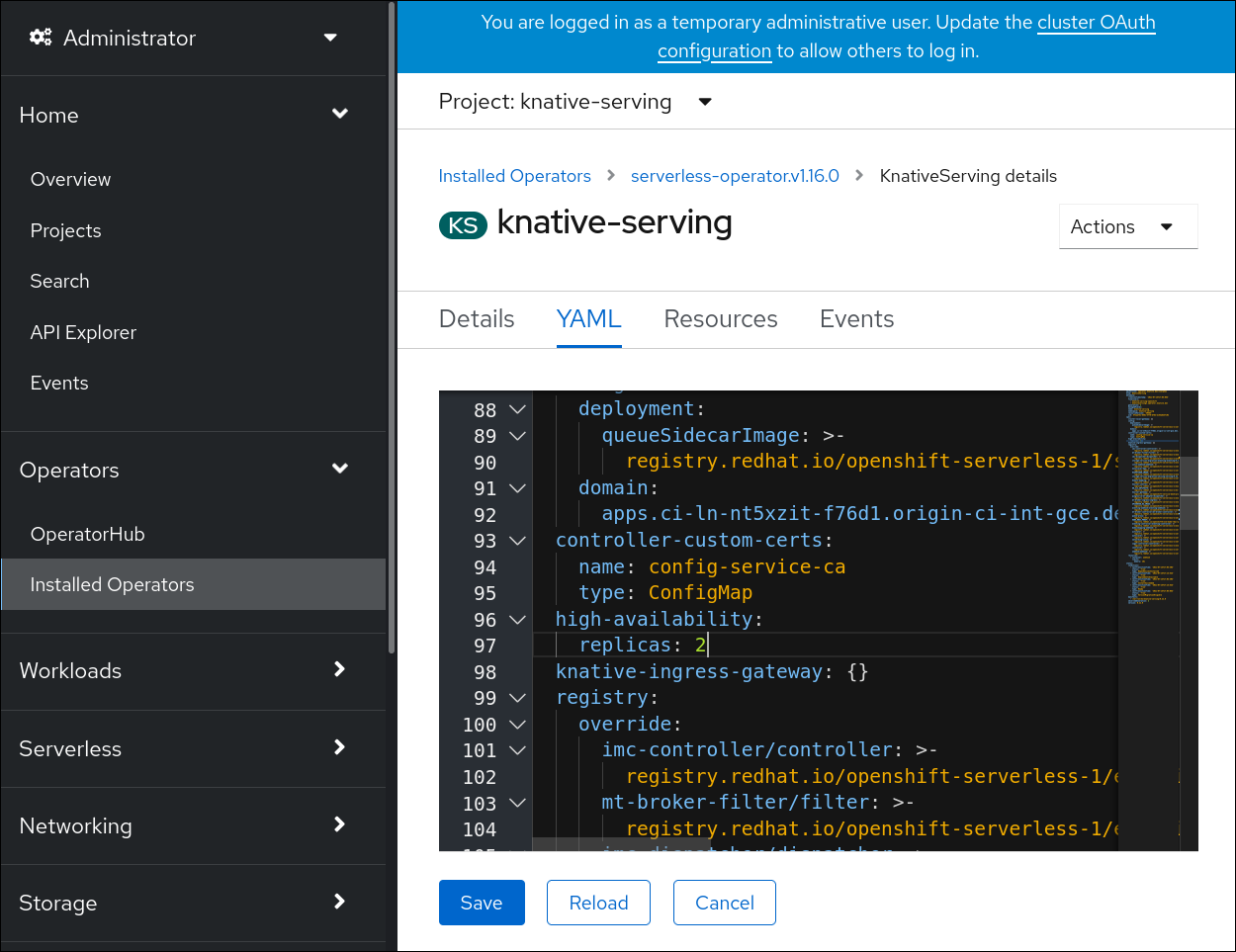

Si vous avez activé la haute disponibilité (HA) sur votre cluster, cela nécessite entre 0,5 et 1,5 cœurs et entre 200 Mo et 2 Go de mémoire pour chaque réplique du plan de contrôle de Knative Serving. HA est activé par défaut pour certains composants de Knative Serving. Vous pouvez désactiver HA en suivant la documentation sur "Configuring high availability replicas".

3.2. Installation de l'opérateur OpenShift Serverless

L'installation de l'OpenShift Serverless Operator vous permet d'installer et d'utiliser Knative Serving, Knative Eventing et le courtier Knative pour Apache Kafka sur un cluster OpenShift Container Platform. OpenShift Serverless Operator gère les définitions de ressources personnalisées (CRD) Knative pour votre cluster et vous permet de les configurer sans modifier directement les cartes de configuration individuelles pour chaque composant.

3.2.1. Installer l'opérateur OpenShift Serverless depuis la console web

Vous pouvez installer l'Opérateur OpenShift Serverless depuis l'OperatorHub en utilisant la console web d'OpenShift Container Platform. L'installation de cet opérateur vous permet d'installer et d'utiliser des composants Knative.

Conditions préalables

- Vous avez accès à un compte OpenShift Container Platform avec un accès administrateur de cluster.

- Votre cluster a la capacité Marketplace activée ou la source du catalogue Red Hat Operator configurée manuellement.

- Vous vous êtes connecté à la console web de OpenShift Container Platform.

Procédure

- Dans la console web d'OpenShift Container Platform, naviguez jusqu'à la page Operators → OperatorHub.

- Faites défiler ou tapez le mot-clé Serverless dans la boîte Filter by keyword pour trouver l'OpenShift Serverless Operator.

- Examinez les informations relatives à l'opérateur et cliquez sur Install.

Sur la page Install Operator:

-

L'adresse Installation Mode est All namespaces on the cluster (default). Ce mode installe l'opérateur dans l'espace de noms par défaut

openshift-serverlessafin qu'il soit surveillé et mis à la disposition de tous les espaces de noms du cluster. -

Le site Installed Namespace est

openshift-serverless. - Sélectionnez le canal stable comme Update Channel. Le canal stable permettra l'installation de la dernière version stable d'OpenShift Serverless Operator.

- Sélectionnez la stratégie d'approbation Automatic ou Manual.

-

L'adresse Installation Mode est All namespaces on the cluster (default). Ce mode installe l'opérateur dans l'espace de noms par défaut

- Cliquez sur Install pour rendre l'opérateur disponible pour les espaces de noms sélectionnés sur ce cluster OpenShift Container Platform.

Depuis la page Catalog → Operator Management, vous pouvez surveiller la progression de l'installation et de la mise à niveau de l'abonnement OpenShift Serverless Operator.

- Si vous avez sélectionné une stratégie d'approbation Manual, l'état de mise à niveau de l'abonnement restera Upgrading jusqu'à ce que vous examiniez et approuviez son plan d'installation. Après approbation sur la page Install Plan, le statut de mise à niveau de l'abonnement passe à Up to date.

- Si vous avez sélectionné une stratégie d'approbation Automatic, le statut du surclassement devrait être résolu à Up to date sans intervention.

Vérification

Une fois que l'état de mise à niveau de l'abonnement est Up to date, sélectionnez Catalog → Installed Operators pour vérifier que l'opérateur OpenShift Serverless finit par apparaître et que son Status se résout finalement en InstallSucceeded dans l'espace de noms concerné.

Si ce n'est pas le cas :

- Passez à la page Catalog → Operator Management et inspectez les onglets Operator Subscriptions et Install Plans pour voir s'il n'y a pas de défaillance ou d'erreur sous Status.

-

Vérifiez les journaux de tous les pods du projet

openshift-serverlesssur la page Workloads → Pods qui signalent des problèmes afin de les résoudre.

Si vous souhaitez utiliser Red Hat OpenShift distributed tracing avec OpenShift Serverless, vous devez installer et configurer Red Hat OpenShift distributed tracing avant d'installer Knative Serving ou Knative Eventing.

3.2.2. Installer l'opérateur OpenShift Serverless depuis le CLI

Vous pouvez installer l'Opérateur OpenShift Serverless depuis le OperatorHub en utilisant le CLI. L'installation de cet opérateur vous permet d'installer et d'utiliser des composants Knative.

Conditions préalables

- Vous avez accès à un compte OpenShift Container Platform avec un accès administrateur de cluster.

- Votre cluster a la capacité Marketplace activée ou la source du catalogue Red Hat Operator configurée manuellement.

- Vous vous êtes connecté au cluster OpenShift Container Platform.

Procédure

Créez un fichier YAML contenant les objets

Namespace,OperatorGroup, etSubscriptionpour abonner un espace de noms à l'opérateur OpenShift Serverless. Par exemple, créez le fichierserverless-subscription.yamlavec le contenu suivant :Exemple d'abonnement

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Le nom du canal de l'opérateur. Le canal

stablepermet l'installation de la version stable la plus récente de l'Opérateur OpenShift Serverless. - 2

- Le nom de l'opérateur auquel s'abonner. Pour l'opérateur OpenShift Serverless, il s'agit toujours de

serverless-operator. - 3

- Le nom du CatalogSource qui fournit l'opérateur. Utilisez

redhat-operatorspour les sources de catalogue par défaut d'OperatorHub. - 4

- L'espace de noms du CatalogSource. Utilisez

openshift-marketplacepour les sources de catalogue par défaut d'OperatorHub.

Créer l'objet

Subscription:oc apply -f serverless-subscription.yaml

$ oc apply -f serverless-subscription.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Vérification

Vérifiez que la version du service de cluster (CSV) a atteint la phase Succeeded:

Example command

$ oc get csv

$ oc get csvExemple de sortie

NAME DISPLAY VERSION REPLACES PHASE serverless-operator.v1.25.0 Red Hat OpenShift Serverless 1.25.0 serverless-operator.v1.24.0 Succeeded

NAME DISPLAY VERSION REPLACES PHASE

serverless-operator.v1.25.0 Red Hat OpenShift Serverless 1.25.0 serverless-operator.v1.24.0 SucceededSi vous souhaitez utiliser Red Hat OpenShift distributed tracing avec OpenShift Serverless, vous devez installer et configurer Red Hat OpenShift distributed tracing avant d'installer Knative Serving ou Knative Eventing.

3.2.3. Configuration globale

L'opérateur OpenShift Serverless gère la configuration globale d'une installation Knative, y compris la propagation des valeurs à partir de KnativeServing et KnativeEventing ressources personnalisées aux cartes de configuration du système. Toute mise à jour des cartes de configuration appliquée manuellement est écrasée par l'Opérateur. Cependant, la modification des ressources personnalisées Knative vous permet de définir des valeurs pour ces cartes de configuration.

Knative dispose de plusieurs cartes de configuration qui sont nommées avec le préfixe config-. Toutes les cartes de configuration Knative sont créées dans le même espace de noms que la ressource personnalisée à laquelle elles s'appliquent. Par exemple, si la ressource personnalisée KnativeServing est créée dans l'espace de noms knative-serving, toutes les cartes de configuration Knative Serving sont également créées dans cet espace de noms.

Les ressources personnalisées Knative spec.config ont une entrée <name> pour chaque carte de configuration, nommée config-<name>, avec une valeur qui sera utilisée pour la carte de configuration data.

3.2.5. Prochaines étapes

- Une fois l'OpenShift Serverless Operator installé, vous pouvez installer Knative Serving ou Knative Eventing.

3.3. Installation du CLI Knative

Le CLI de Knative (kn) n'a pas son propre mécanisme de connexion. Pour vous connecter au cluster, vous devez installer la CLI OpenShift (oc) et utiliser la commande oc login. Les options d'installation des CLI peuvent varier en fonction de votre système d'exploitation.

Pour plus d'informations sur l'installation de l'OpenShift CLI (oc) pour votre système d'exploitation et la connexion avec oc, consultez la documentation de démarrage de l'OpenShift CLI.

OpenShift Serverless ne peut pas être installé à l'aide de la CLI Knative (kn). Un administrateur de cluster doit installer l'opérateur OpenShift Serverless et configurer les composants Knative, comme décrit dans la documentation Installation de l'opérateur OpenShift Serverless.

Si vous essayez d'utiliser une ancienne version du CLI Knative (kn) avec une version plus récente d'OpenShift Serverless, l'API n'est pas trouvée et une erreur se produit.

Par exemple, si vous utilisez la version 1.23.0 du CLI Knative (kn), qui utilise la version 1.2, avec la version 1.24.0 d'OpenShift Serverless, qui utilise les versions 1.3 des API Knative Serving et Knative Eventing, le CLI ne fonctionne pas parce qu'il continue à rechercher les versions dépassées de l'API 1.2.

Assurez-vous que vous utilisez la dernière version du CLI Knative (kn) pour votre version OpenShift Serverless afin d'éviter les problèmes.

3.3.1. Installer le CLI Knative à l'aide de la console web de OpenShift Container Platform

L'utilisation de la console web d'OpenShift Container Platform fournit une interface utilisateur rationalisée et intuitive pour installer le CLI Knative (kn). Après l'installation d'OpenShift Serverless Operator, vous verrez un lien pour télécharger la CLI Knative (kn) pour Linux (amd64, s390x, ppc64le), macOS ou Windows à partir de la page Command Line Tools dans la console web d'OpenShift Container Platform.

Conditions préalables

- Vous vous êtes connecté à la console web de OpenShift Container Platform.

OpenShift Serverless Operator et Knative Serving sont installés sur votre cluster OpenShift Container Platform.

ImportantSi libc n'est pas disponible, vous risquez d'obtenir l'erreur suivante lorsque vous exécutez des commandes CLI :

kn: No such file or directory

$ kn: No such file or directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

Si vous souhaitez utiliser les étapes de vérification pour cette procédure, vous devez installer le CLI OpenShift (

oc).

Procédure

-

Téléchargez le CLI Knative (

kn) à partir de la page Command Line Tools. Vous pouvez accéder à la page Command Line Tools en cliquant sur le dans le coin supérieur droit de la console web et en sélectionnant Command Line Tools dans la liste.

dans le coin supérieur droit de la console web et en sélectionnant Command Line Tools dans la liste.

Décompressez l'archive :

tar -xf <fichier>

tar -xf <fichier>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

Déplacez le fichier binaire

kndans un répertoire de votre sitePATH. Pour vérifier votre

PATH, exécutez :echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Vérification

Exécutez les commandes suivantes pour vérifier que les ressources et la route Knative CLI correctes ont été créées :

oc get ConsoleCLIDownload

$ oc get ConsoleCLIDownloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME DISPLAY NAME AGE kn kn - OpenShift Serverless Command Line Interface (CLI) 2022-09-20T08:41:18Z oc-cli-downloads oc - OpenShift Command Line Interface (CLI) 2022-09-20T08:00:20Z

NAME DISPLAY NAME AGE kn kn - OpenShift Serverless Command Line Interface (CLI) 2022-09-20T08:41:18Z oc-cli-downloads oc - OpenShift Command Line Interface (CLI) 2022-09-20T08:00:20ZCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc get route -n openshift-serverless

$ oc get route -n openshift-serverlessCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD kn kn-openshift-serverless.apps.example.com knative-openshift-metrics-3 http-cli edge/Redirect None

NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD kn kn-openshift-serverless.apps.example.com knative-openshift-metrics-3 http-cli edge/Redirect NoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.2. Installer le CLI Knative pour Linux à l'aide d'un gestionnaire de paquets RPM

Pour Red Hat Enterprise Linux (RHEL), vous pouvez installer le CLI Knative (kn) en tant que RPM à l'aide d'un gestionnaire de paquets, tel que yum ou dnf. Cela permet au système de gérer automatiquement la version du CLI Knative. Par exemple, l'utilisation d'une commande telle que dnf upgrade met à jour tous les paquets, y compris kn, si une nouvelle version est disponible.

Conditions préalables

- Vous disposez d'un abonnement OpenShift Container Platform actif sur votre compte Red Hat.

Procédure

S'inscrire auprès du gestionnaire d'abonnements Red Hat :

subscription-manager register

# subscription-manager registerCopy to Clipboard Copied! Toggle word wrap Toggle overflow Extraire les données d'abonnement les plus récentes :

subscription-manager refresh

# subscription-manager refreshCopy to Clipboard Copied! Toggle word wrap Toggle overflow Attachez l'abonnement au système enregistré :

subscription-manager attach --pool=<pool_id>

# subscription-manager attach --pool=<pool_id>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ID du pool pour un abonnement actif à OpenShift Container Platform

Activer les dépôts requis par le CLI Knative (

kn) :Linux (x86_64, amd64)

subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-x86_64-rpms"

# subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-x86_64-rpms"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Linux sur IBM zSystems et IBM® LinuxONE (s390x)

subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-s390x-rpms"

# subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-s390x-rpms"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Linux sur IBM Power (ppc64le)

subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-ppc64le-rpms"

# subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-ppc64le-rpms"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Installez le CLI Knative (

kn) en tant que RPM à l'aide d'un gestionnaire de paquets :Exemple de commande

yumyum install openshift-serverless-clients

# yum install openshift-serverless-clientsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.3. Installation du CLI Knative pour Linux

Si vous utilisez une distribution Linux qui ne dispose pas de RPM ou d'un autre gestionnaire de paquets, vous pouvez installer le CLI Knative (kn) sous la forme d'un fichier binaire. Pour ce faire, vous devez télécharger et décompresser une archive tar.gz et ajouter le fichier binaire à un répertoire de votre PATH.

Conditions préalables

Si vous n'utilisez pas RHEL ou Fedora, assurez-vous que libc est installé dans un répertoire de votre chemin de bibliothèque.

ImportantSi libc n'est pas disponible, vous risquez d'obtenir l'erreur suivante lorsque vous exécutez des commandes CLI :

kn: No such file or directory

$ kn: No such file or directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Procédure

Téléchargez l'archive Knative (

kn) CLItar.gz:Vous pouvez également télécharger n'importe quelle version de

knen naviguant vers le répertoire correspondant à cette version dans le miroir de téléchargement du client Serverless.Décompressez l'archive :

tar -xf <filename>

tar -xf <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

Déplacez le fichier binaire

kndans un répertoire de votre sitePATH. Pour vérifier votre

PATH, exécutez :echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.4. Installation de la CLI Knative pour macOS

Si vous utilisez macOS, vous pouvez installer le CLI Knative (kn) sous forme de fichier binaire. Pour ce faire, vous devez télécharger et décompresser une archive tar.gz et ajouter le fichier binaire à un répertoire de votre PATH.

Procédure

Téléchargez l'archive du CLI Knative (

kn)tar.gz.Vous pouvez également télécharger n'importe quelle version de

knen naviguant vers le répertoire correspondant à cette version dans le miroir de téléchargement du client Serverless.- Décompressez et extrayez l'archive.

-

Déplacez le fichier binaire

kndans un répertoire de votre sitePATH. Pour vérifier votre

PATH, ouvrez une fenêtre de terminal et exécutez :echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.5. Installation du CLI Knative pour Windows

Si vous utilisez Windows, vous pouvez installer le CLI Knative (kn) sous forme de fichier binaire. Pour ce faire, vous devez télécharger et décompresser une archive ZIP et ajouter le fichier binaire à un répertoire de votre site PATH.

Procédure

Télécharger l'archive ZIP du CLI Knative (

kn).Vous pouvez également télécharger n'importe quelle version de

knen naviguant vers le répertoire correspondant à cette version dans le miroir de téléchargement du client Serverless.- Extraire l'archive à l'aide d'un programme ZIP.

-

Déplacez le fichier binaire

kndans un répertoire de votre sitePATH. Pour vérifier votre

PATH, ouvrez l'invite de commande et exécutez la commande suivante :path

C:\N> pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4. Installation de Knative Serving

L'installation de Knative Serving vous permet de créer des services et des fonctions Knative sur votre cluster. Elle vous permet également d'utiliser des fonctionnalités supplémentaires telles que l'autoscaling et les options de mise en réseau pour vos applications.

Après avoir installé OpenShift Serverless Operator, vous pouvez installer Knative Serving en utilisant les paramètres par défaut ou configurer des paramètres plus avancés dans la ressource personnalisée (CR) KnativeServing. Pour plus d'informations sur les options de configuration de la CR KnativeServing, voir Configuration globale.

Si vous souhaitez utiliser Red Hat OpenShift distributed tracing avec OpenShift Serverless, vous devez installer et configurer Red Hat OpenShift distributed tracing avant d'installer Knative Serving.

3.4.1. Installer Knative Serving en utilisant la console web

Après avoir installé l'OpenShift Serverless Operator, installez Knative Serving en utilisant la console web OpenShift Container Platform. Vous pouvez installer Knative Serving en utilisant les paramètres par défaut ou configurer des paramètres plus avancés dans la ressource personnalisée (CR) KnativeServing.

Conditions préalables

- Vous avez accès à un compte OpenShift Container Platform avec un accès administrateur de cluster.

- Vous vous êtes connecté à la console web de OpenShift Container Platform.

- Vous avez installé OpenShift Serverless Operator.

Procédure

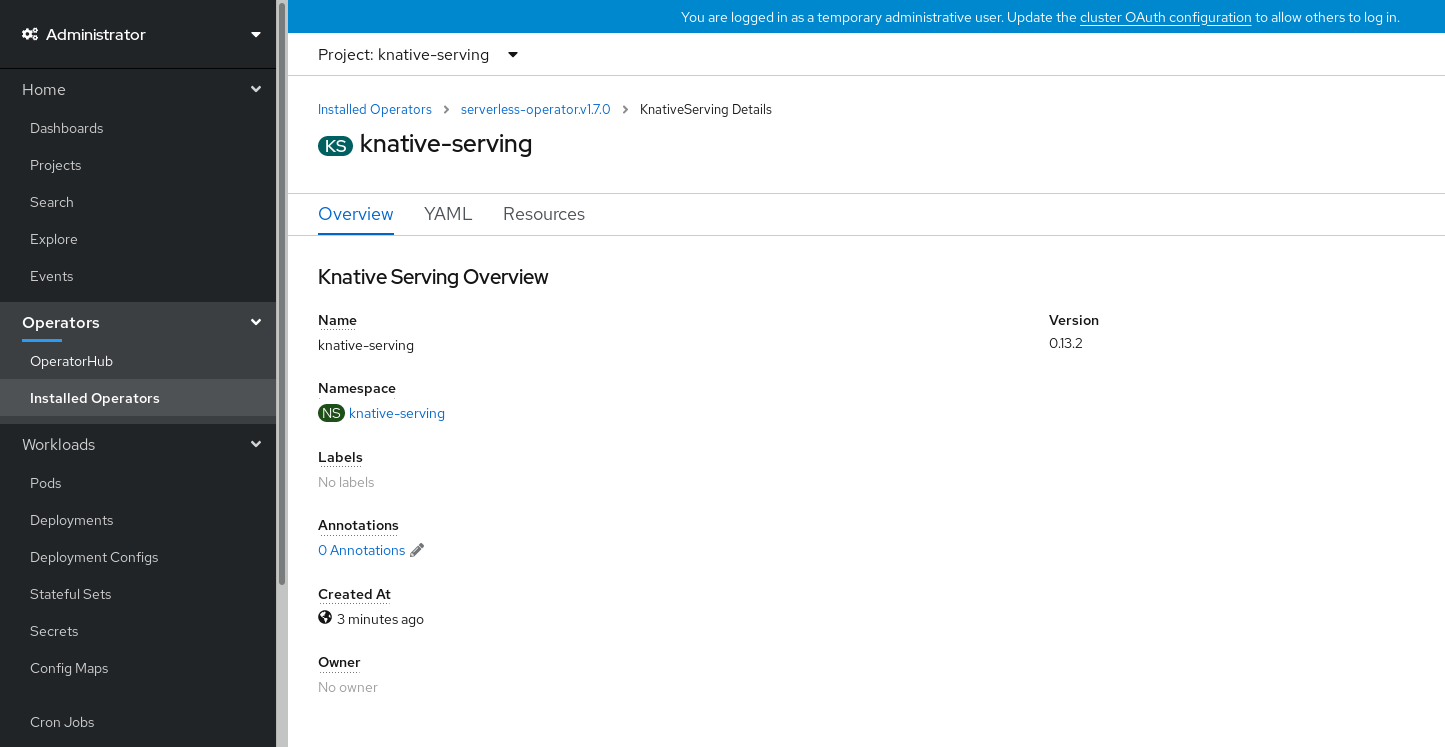

- Dans la perspective Administrator de la console web OpenShift Container Platform, naviguez vers Operators → Installed Operators.

- Vérifiez que le menu déroulant Project en haut de la page est bien réglé sur Project: knative-serving.

- Cliquez sur Knative Serving dans la liste de Provided APIs pour l'OpenShift Serverless Operator afin d'accéder à l'onglet Knative Serving.

- Cliquez sur Create Knative Serving.

Dans la page Create Knative Serving, vous pouvez installer Knative Serving en utilisant les paramètres par défaut en cliquant sur Create.

Vous pouvez également modifier les paramètres de l'installation de Knative Serving en éditant l'objet

KnativeServingà l'aide du formulaire fourni ou en éditant le YAML.-

L'utilisation du formulaire est recommandée pour les configurations plus simples qui ne nécessitent pas un contrôle total de la création des objets

KnativeServing. Il est recommandé d'éditer le YAML pour les configurations plus complexes qui nécessitent un contrôle total de la création des objets

KnativeServing. Vous pouvez accéder au YAML en cliquant sur le lien edit YAML en haut à droite de la page Create Knative Serving.Une fois que vous avez rempli le formulaire ou que vous avez fini de modifier le YAML, cliquez sur Create.

NotePour plus d'informations sur les options de configuration de la définition des ressources personnalisées KnativeServing, voir la documentation sur Advanced installation configuration options.

-

L'utilisation du formulaire est recommandée pour les configurations plus simples qui ne nécessitent pas un contrôle total de la création des objets

-

Après avoir installé Knative Serving, l'objet

KnativeServingest créé et vous êtes automatiquement dirigé vers l'onglet Knative Serving. Vous verrez la ressource personnaliséeknative-servingdans la liste des ressources.

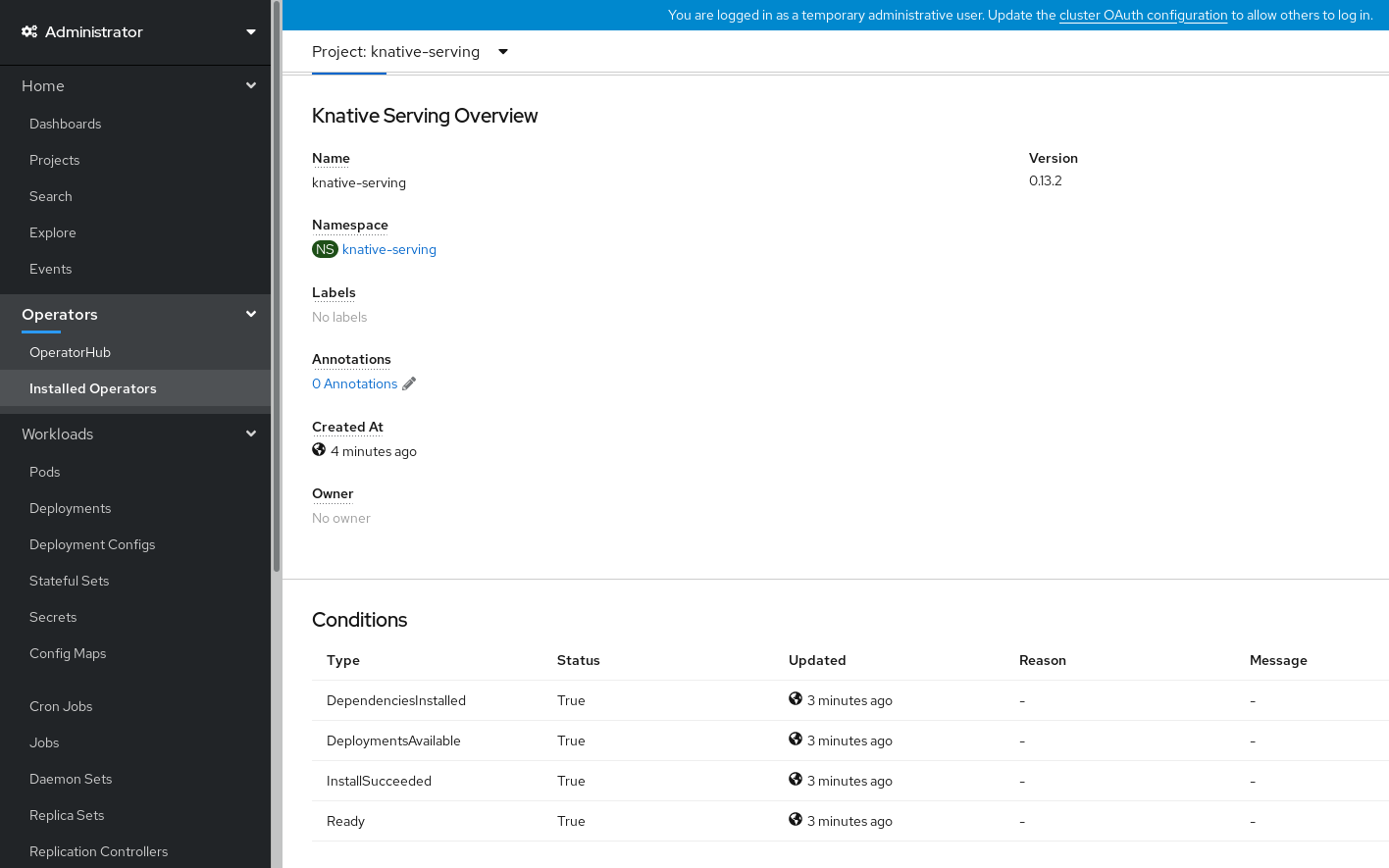

Vérification

-

Cliquez sur

knative-servingcustom resource dans l'onglet Knative Serving. Vous serez automatiquement dirigé vers la page Knative Serving Overview.

- Faites défiler la page vers le bas pour consulter la liste de Conditions.

La liste des conditions dont l'état est True s'affiche, comme le montre l'image d'exemple.

NoteLa création des ressources Knative Serving peut prendre quelques secondes. Vous pouvez vérifier leur statut dans l'onglet Resources.

- Si les conditions ont un statut de Unknown ou False, attendez quelques instants et vérifiez à nouveau après avoir confirmé que les ressources ont été créées.

3.4.2. Installer Knative Serving en utilisant YAML

Après avoir installé OpenShift Serverless Operator, vous pouvez installer Knative Serving en utilisant les paramètres par défaut, ou configurer des paramètres plus avancés dans la ressource personnalisée (CR) KnativeServing. Vous pouvez utiliser la procédure suivante pour installer Knative Serving en utilisant des fichiers YAML et le CLI oc.

Conditions préalables

- Vous avez accès à un compte OpenShift Container Platform avec un accès administrateur de cluster.

- Vous avez installé OpenShift Serverless Operator.

-

Installez le CLI OpenShift (

oc).

Procédure

Créez un fichier nommé

serving.yamlet copiez-y l'exemple YAML suivant :apiVersion: operator.knative.dev/v1beta1 kind: KnativeServing metadata: name: knative-serving namespace: knative-servingapiVersion: operator.knative.dev/v1beta1 kind: KnativeServing metadata: name: knative-serving namespace: knative-servingCopy to Clipboard Copied! Toggle word wrap Toggle overflow Appliquer le fichier

serving.yaml:oc apply -f serving.yaml

$ oc apply -f serving.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Vérification

Pour vérifier que l'installation est terminée, entrez la commande suivante :

oc get knativeserving.operator.knative.dev/knative-serving -n knative-serving --template='{{range .status.conditions}}{{printf "%s=%s\n" .type .status}}{{end}}'$ oc get knativeserving.operator.knative.dev/knative-serving -n knative-serving --template='{{range .status.conditions}}{{printf "%s=%s\n" .type .status}}{{end}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

DependenciesInstalled=True DeploymentsAvailable=True InstallSucceeded=True Ready=True

DependenciesInstalled=True DeploymentsAvailable=True InstallSucceeded=True Ready=TrueCopy to Clipboard Copied! Toggle word wrap Toggle overflow NoteLa création des ressources Knative Serving peut prendre quelques secondes.

Si les conditions ont un statut de

UnknownouFalse, attendez quelques instants et vérifiez à nouveau après avoir confirmé que les ressources ont été créées.Vérifier que les ressources Knative Serving ont été créées :

oc get pods -n knative-serving

$ oc get pods -n knative-servingCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Vérifiez que les composants réseau nécessaires ont été installés dans l'espace de noms

knative-serving-ingresscréé automatiquement :oc get pods -n knative-serving-ingress

$ oc get pods -n knative-serving-ingressCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME READY STATUS RESTARTS AGE net-kourier-controller-7d4b6c5d95-62mkf 1/1 Running 0 76s net-kourier-controller-7d4b6c5d95-qmgm2 1/1 Running 0 76s 3scale-kourier-gateway-6688b49568-987qz 1/1 Running 0 75s 3scale-kourier-gateway-6688b49568-b5tnp 1/1 Running 0 75s

NAME READY STATUS RESTARTS AGE net-kourier-controller-7d4b6c5d95-62mkf 1/1 Running 0 76s net-kourier-controller-7d4b6c5d95-qmgm2 1/1 Running 0 76s 3scale-kourier-gateway-6688b49568-987qz 1/1 Running 0 75s 3scale-kourier-gateway-6688b49568-b5tnp 1/1 Running 0 75sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.3. Prochaines étapes

- Si vous souhaitez utiliser l'architecture événementielle de Knative, vous pouvez installer Knative Eventing.

3.5. Installation de Knative Eventing

Pour utiliser une architecture pilotée par les événements sur votre cluster, installez Knative Eventing. Vous pouvez créer des composants Knative tels que des sources d'événements, des courtiers et des canaux, puis les utiliser pour envoyer des événements à des applications ou à des systèmes externes.

Après avoir installé OpenShift Serverless Operator, vous pouvez installer Knative Eventing en utilisant les paramètres par défaut ou configurer des paramètres plus avancés dans la ressource personnalisée (CR) KnativeEventing. Pour plus d'informations sur les options de configuration de la CR KnativeEventing, voir Configuration globale.

Si vous souhaitez utiliser Red Hat OpenShift distributed tracing avec OpenShift Serverless, vous devez installer et configurer Red Hat OpenShift distributed tracing avant d'installer Knative Eventing.

3.5.1. Installation de Knative Eventing à l'aide de la console web

Après avoir installé l'OpenShift Serverless Operator, installez Knative Eventing en utilisant la console web OpenShift Container Platform. Vous pouvez installer Knative Eventing en utilisant les paramètres par défaut ou configurer des paramètres plus avancés dans la ressource personnalisée (CR) KnativeEventing.

Conditions préalables

- Vous avez accès à un compte OpenShift Container Platform avec un accès administrateur de cluster.

- Vous vous êtes connecté à la console web de OpenShift Container Platform.

- Vous avez installé OpenShift Serverless Operator.

Procédure

- Dans la perspective Administrator de la console web OpenShift Container Platform, naviguez vers Operators → Installed Operators.

- Vérifiez que le menu déroulant Project en haut de la page est bien réglé sur Project: knative-eventing.

- Cliquez sur Knative Eventing dans la liste de Provided APIs pour l'OpenShift Serverless Operator afin d'accéder à l'onglet Knative Eventing.

- Cliquez sur Create Knative Eventing.

Dans la page Create Knative Eventing, vous pouvez choisir de configurer l'objet

KnativeEventingen utilisant le formulaire par défaut fourni ou en modifiant le YAML.L'utilisation du formulaire est recommandée pour les configurations plus simples qui ne nécessitent pas un contrôle total de la création des objets

KnativeEventing.Facultatif. Si vous configurez l'objet

KnativeEventingà l'aide du formulaire, apportez les modifications que vous souhaitez mettre en œuvre pour votre déploiement Knative Eventing.

Cliquez sur Create.