Guide d'administration du stockage

Déployer et configurer un stockage à nœud unique dans Red Hat Enterprise Linux 7

Résumé

Chapitre 1. Aperçu

1.1. Les nouveautés de Red Hat Enterprise Linux 7

eCryptfs non inclus

System Storage Manager

XFS est le Système de fichiers par défaut

Restructuration du système de fichiers

/bin, /sbin, /lib, et /lib64 se trouvent maintenant sous /usr.

Snapper

BTRFS (Aperçu technologique)

NFSv2 n'est plus prise en charge

Partie I. Systèmes de fichiers

Chapitre 2. Structure et maintenance des systèmes de fichiers

- Fichiers partageables vs fichiers non-partageables

- Fichiers variables vs fichiers statiques

2.1. Vue d'ensemble du standard de hiérarchie des systèmes de fichiers (FHS, ou « Filesystem Hierarchy Standard »)

- La compatibilité avec d'autres systèmes conformes à FHS

- La possibilité de monter une partition

/usr/en lecture seule. Ceci est particulièrement important car/usr/contient des fichiers exécutables communs et ne devrait pas être modifié par les utilisateurs. En outre, comme la partition/usr/est montée en lecture seule, elle devrait pouvoir être montée à partir du lecteur CD-ROM ou depuis une autre machine via un montage NFS en lecture seule.

2.1.1. Organisation FHS

Note

2.1.1.1. Collecte des informations sur les systèmes de fichiers

df rapporte l'utilisation de l'espace disque du système. Sa sortie est similaire à la suivante :

Exemple 2.1. Sortie de la commande df

Filesystem 1K-blocks Used Available Use% Mounted on

/dev/mapper/VolGroup00-LogVol00

11675568 6272120 4810348 57% / /dev/sda1

100691 9281 86211 10% /boot

none 322856 0 322856 0% /dev/shm

Filesystem 1K-blocks Used Available Use% Mounted on

/dev/mapper/VolGroup00-LogVol00

11675568 6272120 4810348 57% / /dev/sda1

100691 9281 86211 10% /boot

none 322856 0 322856 0% /dev/shmdf affiche la taille de la partition en blocs de 1 kilo-octets, ainsi que la quantité d'espace disque utilisée et disponible en kilo-octets. Pour afficher ces informations en méga-octets et giga-octets, veuillez exécuter la commande df -h. L'argument -h se traduit par l'utilisation d'un format lisible (« human-readable »). La sortie de df -h est similaire à la suivante :

Exemple 2.2. Sortie de la commande df -h

Filesystem Size Used Avail Use% Mounted on

/dev/mapper/VolGroup00-LogVol00

12G 6.0G 4.6G 57% / /dev/sda1

99M 9.1M 85M 10% /boot

none 316M 0 316M 0% /dev/shm

Filesystem Size Used Avail Use% Mounted on

/dev/mapper/VolGroup00-LogVol00

12G 6.0G 4.6G 57% / /dev/sda1

99M 9.1M 85M 10% /boot

none 316M 0 316M 0% /dev/shmNote

/dev/shm représente le système de fichiers de la mémoire virtuelle du système.

du affiche la quantité estimée d'espace utilisé par des fichiers dans un répertoire, et l'utilisation d'espace disque de chaque sous-répertoire. La dernière ligne dans la sortie de du affiche la totalité de l'utilisation d'espace disque du répertoire. Pour afficher la totalité de l'utilisation d'espace disque sous un format lisible, veuillez utiliser du -hs. Pour plus d'options, veuillez consulter man du.

gnome-system-monitor. Sélectionnez l'onglet Systèmes de fichiers pour afficher les partitions du système. La figure ci-dessous illustre l'onglet Systèmes de fichiers.

Figure 2.1. Onglet Surveillance système GNOME des systèmes de fichiers

2.1.1.2. Répertoire /boot/

/boot/ contient des fichiers statiques requis pour démarrer le système, par exemple le noyau Linux. Ces fichiers sont essentiels pour que le système puisse démarrer correctement.

Avertissement

/boot/. Le système ne pourra plus être démarré si ce répertoire est supprimé.

2.1.1.3. Répertoire /dev/

/dev/ contient des nœuds de périphériques qui représente les types de périphériques suivants :

- les périphériques attachés au système ;

- les périphériques fournis par le noyau.

udevd crée et supprime les nœuds de périphérique dans /dev/ selon les besoins.

/dev/ et ses sous-répertoires sont définis en tant que caractère (fournissant uniquement un flux en série d'entrées et sortie, par exemple une souris ou un clavier) ou bloc (accessible de manière aléatoire, par exemple un disque dur ou un lecteur de disquettes). Si GNOME ou KDE est installé, certains périphériques de stockage seront automatiquement détectés lorsqu'ils sont connectés (comme les lecteurs USB), ou insérés (comme avec un lecteur CD ou DVD), puis une fenêtre contextuelle affichant le contenu apparaîtra.

| Fichier | Description |

|---|---|

| /dev/hda | Périphérique maître sur le canal IDE principal. |

| /dev/hdb | Périphérique esclave sur le canal IDE principal. |

| /dev/tty0 | Première console virtuelle. |

| /dev/tty1 | Seconde console virtuelle. |

| /dev/sda | Premier périphérique sur le canal principal SCSI ou SATA. |

| /dev/lp0 | Premier port parallèle. |

- Un périphérique mappé

- Un volume logique dans un groupe de volumes. Par exemple,

/dev/mapper/VolGroup00-LogVol02. - Un périphérique statique

- Un volume de stockage traditionnel. Par exemple,

/dev/sdbX, où sdb est un nom de périphérique de stockage et où X est le numéro de la partition./dev/sdbXpeut également être/dev/disk/by-id/WWID, ou/dev/disk/by-uuid/UUID, (voir Section 24.7, « Dénomination persistante » pour obtenir plus d'informations sur ces options).

2.1.1.4. Répertoire /etc/

/etc/ est réservé aux fichiers de configuration qui sont locaux à l'ordinateur. Il ne doit contenir aucun fichier binaire ; tout fichier binaire devrait être déplacé dans /usr/bin/ ou /usr/sbin/.

/etc/skel/ stocke les fichiers utilisateur « squelette », qui sont utilisés pour remplir un répertoire de base lorsqu'un utilisateur est créé pour la première fois. Les applications stockent aussi leurs fichiers de configuration dans ce répertoire et peuvent les référencer lors de leur exécution. Le fichier /etc/exports contrôle quels systèmes de fichiers sont exportés vers des hôtes distants.

2.1.1.5. Répertoire /mnt/

/mnt/ est réservé aux systèmes de fichiers montés de manière temporaire, comme les montages de systèmes de fichiers NFS. Pour tous les supports de stockage amovibles, veuillez utiliser le répertoire /media/. Les supports de stockage amovibles détectés automatiquement seront montés dans le répertoire /media.

Important

/mnt ne doit pas être utilisé par des programmes d'installation.

2.1.1.6. Répertoire /opt/

/opt/ est habituellement réservé aux paquets logiciels et aux paquets de modules complémentaires ne faisant pas partie de l'installation par défaut. Un paquet effectuant une installation sur /opt/ crée un répertoire portant son nom, par exemple, /opt/packagename/. Dans la plupart des cas, ce genre de paquets observe une structure prédictible de sous-répertoires. La plupart stockent leurs binaires dans /opt/packagename/bin/ et leurs pages man dans /opt/packagename/man/.

2.1.1.7. Répertoire /proc/

/proc/ contient des fichiers spéciaux qui extraient des informations du noyau ou y envoient des informations. Des exemples de ce genre d'informations incluent la mémoire système, des informations sur le CPU et la configuration du matériel. Pour obtenir des informations supplémentaires sur /proc/, veuillez consulter le Section 2.3, « Système de fichiers virtuel /proc ».

2.1.1.8. Répertoire /srv/

/srv/ contient des données spécifiques au site servies par un système Red Hat Enterprise Linux. Ce répertoire donne aux utilisateurs l'emplacement des fichiers de données pour un service particulier, tel que FTP, WWW, ou CVS. Les données pertinentes à un utilisateur en particulier doivent être placées dans le répertoire /home/.

2.1.1.9. Répertoire /sys/

/sys/ utilise le nouveau système de fichiers virtuel spécifique au noyau, sysfs. Grâce à la meilleure prise en charge de l'enfichage à chaud de périphériques matériels dans le noyau, le répertoire /sys/ contient des informations similaires à celles qui sont offertes par /proc/, mais affiche une vue hiérarchique des informations des périphériques qui est spécifique aux périphériques enfichables à chaud.

2.1.1.10. Répertoire /usr/

/usr/ est utilisé pour les fichiers pouvant être partagés à travers de multiples machines. Le répertoire /usr/ se trouve souvent sur sa propre partition et est monté en lecture seule. Au minimum, le répertoire /usr/ doit contenir les sous-répertoires suivants :

/usr/bin- Ce répertoire est utilisé pour les binaires.

/usr/etc- Ce répertoire est utilisé pour les fichiers de configuration globaux.

/usr/games- Ce répertoire est utilisé pour stocker les jeux.

/usr/include- Ce répertoire est utilisé pour les fichiers en-têtes C.

/usr/kerberos- Ce répertoire est utilisé pour les fichiers et binaires liés à Kerberos.

/usr/lib- Ce répertoire est utilisé pour les fichiers objets et les bibliothèques qui ne sont pas conçus pour être directement utilisés par des scripts shell ou des utilisateurs.À partir de Red Hat Enterprise Linux 7.0, le répertoire

/lib/a été mergé avec/usr/lib. Il doit également contenir les bibliothèques nécessaires à l'exécution des binaires dans/usr/bin/et/usr/sbin/. Ces images de bibliothèques partagées sont utilisées pour démarrer le système ou exécuter des commandes à l'intérieur du système de fichiers. /usr/libexec- Ce répertoire contient les programmes d'assistance de petite taille appelés par d'autres programmes.

/usr/sbin- À partir de Red Hat Enterprise Linux 7.0,

/sbina été déplacé dans/usr/sbin. Cela signifie qu'il contient tous les binaires d'administration système, y compris ceux qui sont essentiels pour démarrer, restaurer, recouvrer ou réparer le système. Les binaires de/usr/sbin/ont besoin de privilèges root pour être utilisés. /usr/share- Ce répertoire stocke les fichiers qui ne sont pas particuliers à l'architecture.

/usr/src- Ce répertoire stocke le code source.

/usr/tmplié à/var/tmp- Ce répertoire stocke les fichiers temporaires.

/usr/ devrait aussi contenir un sous-répertoire /local/. Comme recommandé par la norme FHS, ce sous-répertoire est utilisé par l'administrateur système lors de l'installation locale de logiciels et ne doit pas être écrasé pendant les mises à jour du système. Le répertoire /usr/local possède une structure similaire à /usr/ et contient les sous-répertoires suivants :

/usr/local/bin/usr/local/etc/usr/local/games/usr/local/include/usr/local/lib/usr/local/libexec/usr/local/sbin/usr/local/share/usr/local/src

/usr/local/ diffère légèrement de la norme FHS. La norme FHS déclare que /usr/local/ doit être utilisé pour stocker des logiciels qui ne doivent pas être affectés par les mises à niveau de logiciels système. Comme le gestionnaire de paquet RPM, « RPM Package Manager », peut effectuer des mises à niveau de logiciels en toute sécurité, il n'est pas nécessaire de protéger les fichiers en les stockant dans /usr/local/.

/usr/local/ pour les logiciels locaux. Par exemple, si le répertoire /usr/ est monté en tant que partage NFS, en lecture seule, à partir d'un hôte distant, il est toujours possible d'installer un paquet ou programme sous le répertoire /usr/local/.

2.1.1.11. Répertoire /var/

/usr/ en lecture seule, tout programme qui écrit des fichiers journaux ou nécessite les répertoires spool/ ou lock/ doit les écrire sur le répertoire /var/. La norme FHS déclare que /var/ est utilisé pour les données variables, ce qui inclut les répertoires et fichier spool, les données de journalisation, et les fichiers transitoires et temporaires.

/var/ :

/var/account//var/arpwatch//var/cache//var/crash//var/db//var/empty//var/ftp//var/gdm//var/kerberos//var/lib//var/local//var/lock//var/log//var/maillié à/var/spool/mail//var/mailman//var/named//var/nis//var/opt//var/preserve//var/run//var/spool//var/tmp//var/tux//var/www//var/yp/

Important

/var/run/media/user contient des sous-répertoires utilisés comme points de montage pour des supports amovibles, tels que les supports de stockage USB, les DVD, les CD-ROM, et les disques Zip. Notez qu'auparavant, le répertoire /media/ était utilisé pour cela.

messages et lastlog, sont placés dans le répertoire /var/log/. Le répertoire /var/lib/rpm/ contient des bases de données RPM du système. Les fichiers de verrouillage sont placés dans le répertoire /var/lock/, habituellement dans les répertoires du programme utilisant le fichier. Le répertoire /var/spool/ contient des sous-répertoires qui stockent les fichiers de données de certains programmes. Ces sous-répertoires incluent :

/var/spool/at//var/spool/clientmqueue//var/spool/cron//var/spool/cups//var/spool/exim//var/spool/lpd//var/spool/mail//var/spool/mailman//var/spool/mqueue//var/spool/news//var/spool/postfix//var/spool/repackage//var/spool/rwho//var/spool/samba//var/spool/squid//var/spool/squirrelmail//var/spool/up2date//var/spool/uucp//var/spool/uucppublic//var/spool/vbox/

2.2. Emplacement des fichiers Red Hat Enterprise Linux spéciaux

/var/lib/rpm/. Pour obtenir des informations supplémentaires sur les RPM, veuillez consulter man rpm.

/var/cache/yum/ contient des fichiers utilisés par Package Updater, y compris les informations d'en-tête RPM de ce système. L'emplacement peut aussi être utilisé pour stocker temporairement les RPM téléchargés pendant la mise à jour du système. Pour obtenir davantage d'informations sur Red Hat Network, veuillez consulter la documentation en ligne sur https://rhn.redhat.com/.

/etc/sysconfig/ est un autre emplacement spécifique à Red Hat Enterprise Linux. Ce répertoire stocke toute un ensemble d'informations de configuration. De nombreux scripts exécutés lors du démarrage utilisent des fichiers situés dans ce répertoire.

2.3. Système de fichiers virtuel /proc

/proc ne contient ni texte, ni fichiers binaires. Au lieu de cela, il héberge des fichiers virtuels ; ainsi, /proc fait habituellement référence à un système de fichiers virtuel. La taille typique de ces fichiers virtuels est de zéro octets, même s'ils contiennent de grandes quantités d'informations.

/proc n'est pas utilisé pour le stockage. Son but principal est de fournir une interface basée sur fichiers pour le matériel, la mémoire, les processus en cours d'exécution, ainsi que pour les autres composants du système. Des informations en temps réel peuvent être récupérées sur de nombreux composants de système en affichant son fichier /proc correspondant. Certains des fichiers dans /proc peuvent également être manipulés (par les utilisateurs et les applications) pour configurer le noyau.

/proc suivants sont utiles pour le contrôle et la gestion du stockage du système :

- /proc/devices

- Affiche divers périphériques bloc et caractères actuellement configurés.

- /proc/filesystems

- Répertorie les types de systèmes de fichiers actuellement pris en charge par le noyau.

- /proc/mdstat

- Contient des informations sur les configurations à disques multiples ou les configurations RAID sur le système, s'il y en a.

- /proc/mounts

- Répertorie tous les montages en cours d'utilisation par le système.

- /proc/partitions

- Contient les informations sur l'allocation de blocs de partitions.

/proc, veuillez consulter le Guide de déploiement Red Hat Enterprise Linux 7.

2.4. Abandonner les blocs inutilisés

fstrim. Cette commande abandonne tous les blocs inutilisés dans un système de fichiers correspondant aux critères de l'utilisateur. Ces deux types d'opération sont pris en charge pour une utilisation avec les systèmes de fichier ext4 dans Red Hat Enterprise Linux 6.2 et ses versions supérieures, tant que le périphérique bloc sous-jacent au système de fichiers prend en charge les opérations d'abandon physique. Ceci est aussi le cas avec les systèmes de fichiers XFS dans Red Hat Enterprise Linux 6.4 et ses versions supérieures. Les opérations d'abandon physique sont prises en charge si la valeur de /sys/block/device/queue/discard_max_bytes n'est pas zéro.

-o discard (soit dans /etc/fstab ou en faisant partie de la commande mount) et elles sont exécutées en temps réel sans intervention de la part de l'utilisateur. Les opérations d'abandon en ligne abandonnent uniquement les blocs passant de « Utilisé » à « Libre ». Les opérations d'abandon en ligne sont prises en charge sur les systèmes de fichiers ext4 dans Red Hat Enterprise Linux 6.2 et ses versions supérieures, ainsi que sur les systèmes de fichiers XFS dans Red Hat Enterprise Linux 6.4 et ses versions supérieures.

Chapitre 3. Btrfs (Aperçu technologique)

Important

3.1. Création d'un système de fichiers btrfs

mkfs.btrfs /dev/device

# mkfs.btrfs /dev/device3.2. Monter un système de fichiers btrfs

mount /dev/device /mount-point

# mount /dev/device /mount-point- device=/dev/name

- En ajoutant cette option à la commande de montage ordonne btrfs à scanner un volume btfs dans le périphérique nommé. C'est utilisé pour veiller à ce que le montage réussisse car tenter de monter les périphériques qui ne sont pas btrfs peuvent entraîner l'échec du montage.

Note

Cela ne signifie pas que tous les périphériques seront ajoutés au système de fichiers, cela ne fait que de les scanner. - max_inline=number

- Utiliser cette option pour définir le montant d'espace maximum (en octets) pouvant être utilisé pour aligner les données dans un B-tree Leaf de métadonnées. La valeur par défaut est de 8192 octets.

- alloc_start=number

- Utiliser cette option pour définir où les allocations débutent dans le disque.

- thread_pool=number

- Utiliser cette option pour assigner le nombre de threads de workers alloués.

- discard

- Utiliser cette option pour activer discard/TRIM sur les blocs libérés.

- noacl

- Utiliser cette option pour désactiver l'utilisation des ACL.

- space_cache

- Utiliser cette option pour libérer les données d'espace libre du disque pour mettre en cache un groupe de blocs plus rapidement. Il s'agit d'un changement persistant et on peut amorcer d'anciens noyaus en toute sécurité.

- nospace_cache

- Utiliser cette option pour désactiver le

space_cacheci-dessus. - clear_cache

- Utiliser cette option pour libérer les caches d'espace-libre pendant le montage. Il s'agit d'une option sûre mais qui entraînera sa reconstruction. Par conséquence, laissez le système de fichiers monté pour que le processus de reconstruction puisse s'achever. Cette option de montage à pour but d'être utilisée une fois et uniquement après que les problèmes d'espace libre soient apparents.

- enospc_debug

- Cette option est utilisée pour déboguer les problèmes "no space left"

- recovery

- Utiliser cette option pour permettre le recouvrement automatique lors du montage.

3.3. Redimensionner un système de fichiers btrfs

Note

G ou g sont acceptés pour GiB.

t pour terabytes ou p pour petabytes. Elle accepte uniquement k, m, et g.

Comment élargir un système de fichiers btrfs

btrfs filesystem resize amount /mount-point

# btrfs filesystem resize amount /mount-pointbtrfs filesystem resize +200M /btrfssingle Resize '/btrfssingle' of '+200M'

# btrfs filesystem resize +200M /btrfssingle

Resize '/btrfssingle' of '+200M'btrfs filesystem show /mount-point

# btrfs filesystem show /mount-pointdevid du périphérique à élargir, utiliser la commande suivante :

btrfs filesystem resize devid:amount /mount-point

# btrfs filesystem resize devid:amount /mount-pointbtrfs filesystem resize 2:+200M /btrfstest Resize '/btrfstest/' of '2:+200M'

# btrfs filesystem resize 2:+200M /btrfstest

Resize '/btrfstest/' of '2:+200M'Note

max au lieu d'un montant spécifique. Cela utilisera tout l'espace libre restant qui se trouve sur le périphérique.

Réduire un système de fichiers btrfs

btrfs filesystem resize amount /mount-point

# btrfs filesystem resize amount /mount-pointbtrfs filesystem resize -200M /btrfssingle Resize '/btrfssingle' of '-200M'

# btrfs filesystem resize -200M /btrfssingle

Resize '/btrfssingle' of '-200M'btrfs filesystem show /mount-point

# btrfs filesystem show /mount-pointdevid du périphérique à réduire, utiliser la commande suivante :

btrfs filesystem resize devid:amount /mount-point

# btrfs filesystem resize devid:amount /mount-pointbtrfs filesystem resize 2:-200M /btrfstest Resize '/btrfstest' of '2:-200M'

# btrfs filesystem resize 2:-200M /btrfstest

Resize '/btrfstest' of '2:-200M'Définir la taille du système de fichiers

btrfs filesystem resize amount /mount-point

# btrfs filesystem resize amount /mount-pointbtrfs filesystem resize 700M /btrfssingle Resize '/btrfssingle' of '700M'

# btrfs filesystem resize 700M /btrfssingle

Resize '/btrfssingle' of '700M'btrfs filesystem show /mount-point

# btrfs filesystem show /mount-pointdevid du périphérique à modifier, utiliser la commande suivante :

btrfs filesystem resize devid:amount /mount-point

# btrfs filesystem resize devid:amount /mount-pointbtrfs filesystem resize 2:300M /btrfstest Resize '/btrfstest' of '2:300M'

# btrfs filesystem resize 2:300M /btrfstest

Resize '/btrfstest' of '2:300M'3.4. Gestion des volumes intégrés de plusieurs périphériques

3.4.1. Création de système de fichiers avec plusieurs périphériques

mkfs.btrfs détaillée dans Section 3.1, « Création d'un système de fichiers btrfs » accepte les options -d pour les données, et -m pour les métadonnées. Les spéfifications acceptées sont :

raid0raid1raid10dupsingle

-m single indique qu'aucun duplicata de métadonnées n'a lieu. C'est souhaitable quand on utilise un raid de matériel.

Note

Exemple 3.1. Créer un système de fichiers btrfs Raid 10

mkfs.btrfs /dev/device1 /dev/device2 /dev/device3 /dev/device4

# mkfs.btrfs /dev/device1 /dev/device2 /dev/device3 /dev/device4mkfs.btrfs -m raid0 /dev/device1 /dev/device2

# mkfs.btrfs -m raid0 /dev/device1 /dev/device2mkfs.btrfs -m raid10 -d raid10 /dev/device1 /dev/device2 /dev/device3 /dev/device4

# mkfs.btrfs -m raid10 -d raid10 /dev/device1 /dev/device2 /dev/device3 /dev/device4mkfs.btrfs -m single /dev/device

# mkfs.btrfs -m single /dev/devicesingle pour utiliser toute la capacité de chaque disque quand les disques sont de tailles différentes.

mkfs.btrfs -d single /dev/device1 /dev/device2 /dev/device3

# mkfs.btrfs -d single /dev/device1 /dev/device2 /dev/device3btrfs device add /dev/device1 /mount-point

# btrfs device add /dev/device1 /mount-pointbtrfs device scan pour découvrir tous les systèmes de fichiers multi-périphériques. Voir Section 3.4.2, « btrfs device scan pour périphériques multiples » pour obtenir plus d'informations.

3.4.2. btrfs device scan pour périphériques multiples

btrfs device scan pour scanner tous les périphériques blocs sous /dev et cherchez les volumes btrfs. Cela doit être effectué après le chargement du module btfrs si vous exécutez plus d'un périphérique dans un système de fichiers.

btrfs device scan

# btrfs device scanbtrfs device scan /dev/device

# btrfs device scan /dev/device3.4.3. Ajouter des nouveaux périphériques à un système de fichiers btrfs

btrfs filesystem show pour faire la liste de tous les systèmes de fichiers btrfs et des périphériques qu'ils incluent.

btrfs device add est utilisée pour ajouter des nouveaux périphériques à un système de fichiers monté.

btrfs filesystem balance équilibre (redistribue) les extensions allouées à tous les périphériques existants.

Exemple 3.2. Ajouter un nouveau périphérique à un système de fichiers btrfs

mkfs.btrfs /dev/device1 mount /dev/device1

# mkfs.btrfs /dev/device1

# mount /dev/device1btrfs device add /dev/device2 /mount-point

# btrfs device add /dev/device2 /mount-point/dev/device1. Elles doivent maintenant être réparties équitablement entre les périphériques.

btrfs filesystem balance /mount-point

# btrfs filesystem balance /mount-point3.4.4. Convertir un système de fichiers btrfs

Exemple 3.3. Convertir un système de fichiers btrfs

/dev/sdb1 dans un tel cas, et en deux périphériques, un système raid 1 pour se protéger des défaillances du disque, utiliser la commande suivante :

mount /dev/sdb1 /mnt btrfs device add /dev/sdc1 /mnt btrfs balance start -dconvert=raid1 -mconvert=raid1 /mnt

# mount /dev/sdb1 /mnt

# btrfs device add /dev/sdc1 /mnt

# btrfs balance start -dconvert=raid1 -mconvert=raid1 /mntImportant

3.4.5. Suppression des périphériques btrfs

btrfs device delete pour supprimer un périphérique en ligne. Redistribue toute extension utilisée par d'autres périphériques du système de fichiers pour une suppression en toute sécurité.

Exemple 3.4. Supprimer un périphérique sur un système de fichiers btrfs

mkfs.btrfs /dev/sdb /dev/sdc /dev/sdd /dev/sde mount /dev/sdb /mnt

# mkfs.btrfs /dev/sdb /dev/sdc /dev/sdd /dev/sde

# mount /dev/sdb /mntbtrfs device delete /dev/sdc /mnt

# btrfs device delete /dev/sdc /mnt3.4.6. Remplacer les périphériques qui ont échoué sur le système de fichiers btrfs

btrfs device delete missing supprime le premier périphérique qui est décrit dans les métadonnées du système de fichiers, mais qui n'était pas présent quand le système de fichiers a été monté.

Important

- monter en mode dégradé,

- ajouter un nouveau périphérique,

- et, supprimer le périphérique manquant.

3.4.7. Enregistrer un système de fichiers btrfs dans /etc/fstab

initrd ou si le périphérique btrfs ne peut avoir lieu, il est possible de monter un système de fichiers btrfs multi volumes en passant tous les périphériques du système de fichiers explicitement à la commande mount.

Exemple 3.5. Exemple de saisie /etc/fstab

/etc/fstab qui conviendrait :

/dev/sdb /mnt btrfs device=/dev/sdb,device=/dev/sdc,device=/dev/sdd,device=/dev/sde 0

/dev/sdb /mnt btrfs device=/dev/sdb,device=/dev/sdc,device=/dev/sdd,device=/dev/sde 03.5. Optimisation SSD

mkfs.btrfs qui ferme la duplication des métadonnées sur un seul périphérique quand/sys/block/device/queue/rotational est sur zéro pour le périphérique indiqué. Cela revient à spécifier -m single sur la ligne de comande. Cela peut être remplacé et la duplication des métadonnées peut être forcée grâce à l'option -m dup. La duplication n'est pas requise car SSD firmware peut perdre les deux copies. C'est une perte d'espace et un cout rajouté à la performance.

ssd, nossd, et ssd_spread.

ssd fait plusieurs choses :

- Cela permet une allocation de cluster de métadonnées plus importante.

- Cela permet de distribuer des données de manière plus séquentielle lorsque cela est possible.

- Désactive la ré-écriture de feuille btree pour établir une correspondance avec la clé et l'ordre des blocs.

- Valide les fragments de journaux sans regrouper plusieurs processus.

Note

ssd n'active que l'option ssd. Utiliser l'option nossd pour la désactiver.

mount -o ssd cherchera des groupements de blocs quand il y a plusieurs blocs de libre qui auraient pu avoir des blocs distribués mélangés. La commande mount -o ssd_spread veille à ce qu'il n'y ait aucuns blocs distribués de mélangés. Cela améliore la performance à la base des SSD.

Note

ssd_spread active les options ssd et ssd_spread à la fois. Utiliser nossd pour désactiver ces options.

ssd_spread n'est jamais définie automatiquement si aucune de ces options SSD ne sont fournies et qu'aucun des périphériques est non-rotationnel.

3.6. Références btrfs

btrfs(8) couvre toutes les commandes de gestion importantes. Inclut tout particulièrement :

- Toutes les commandes de sous-volumes pour gérer les clichés.

- Les commandes de

devicepour gérer les périphériques. - Les commandes

scrub,balance, etdefragment.

mkfs.btrfs(8) contient des informations sur la façon de créer un système de fichiers btrfs qui inclut toutes les options à son sujet.

btrfsck(8) est pour les informations fsck à propos des systèmes btrfs.

Chapitre 4. Système de fichiers Ext3

- Disponibilité

- Après une panne d'alimentation ou une panne du système inattendue (aussi appelé un arrêt du système incorrect), la cohérence de chaque système de fichiers ext2 monté sur la machine doit être vérifiée par le programme

e2fsck. Ce long processus peut retarder le démarrage du système de manière importante, particulièrement pour les volumes de grande taille contenant de nombreux fichiers. Pendant ce délai, on ne peut pas accéder aux données sur les volumes.Il est possible d'exécuterfsck -nsur un système de fichiers en direct. Cependant, aucun changement ne sera effectué et des résultats trompeurs pourraient être retournés s'il y a des métadonnées partiellement écrites.Si LVM est utilisé dans la pile, une autre option consiste à prendre un cliché LVM du système de fichiers et d'exécuterfsckdessus à la place.Finalement, il existe une option pour remonter le système de fichiers en lecture seule. Toutes les mises à jour (et écritures) de métadonnées en attente sont ensuite forcées sur le disque avant qu'il soit remonté. Ceci permet d'assurer que le système de fichiers se trouve dans un état cohérent, à condition qu'il n'y ait pas de corruption précédente. Il est désormais possible d'exécuterfsck -n.La journalisation offerte par le système de fichiers ext3 signifie que ce type de vérification de système de fichiers n'est plus nécessaire après un arrêt du système incorrect. La seule fois qu'une vérification de cohérence se produit en utilisant ext3 est dans certains rares cas de panne de matériel, comme lors de pannes de disque dur. Le temps pris pour récupérer un système de fichiers ext3 après un arrêt de système incorrect ne dépend pas de la taille du système de fichiers ou du nombre de fichiers, il dépend de la taille du journal utilisé pour maintenir une certaine cohérence. La taille de journal par défaut prend environ une seconde pour reprendre, en fonction de la vitesse du matériel.Note

Le seul mode de journalisation d'ext3 pris en charge par Red Hat estdata=ordered(par défaut). - Intégrité des données

- Le système de fichiers ext3 empêche la perte d'intégrité des données dans le cas où un arrêt du système incorrect se produirait. Le système de fichiers ext3 vous permet de choisir le type et le niveau de protection pour vos données. Quant à l'état du système de fichiers, les volumes ext3 sont configurés de manière à fournir un haut niveau de cohérence des données par défaut.

- Vitesse

- Malgré l'écriture de certaines données plus d'une fois, ext3 possède un plus haut débit que ext2 dans la plupart des cas car la journalisation d'ext3 optimise les mouvements de disque dur. Vous pouvez choisir parmi trois modes de journalisation pour optimiser la vitesse, mais ce faire entrainera des compromis au niveau de l'intégrité des données si jamais le système devait tomber en panne.

Note

Le seul mode de journalisation d'ext3 pris en charge par Red Hat estdata=ordered(par défaut). - Transition facile

- Il est facile de migrer d'ext2 à ext3 et de tirer profit des bénéfices d'un système de fichiers offrant une journalisation robuste sans reformatage. Veuillez consulter la Section 4.2, « Conversion vers un système de fichiers ext3 » pour obtenir des informations supplémentaire sur la manière d'accomplir cette tâche.

Note

ext4.ko pour ces formats sur disque. Cela signifie que les messages de noyau se référeront toujours à ext4 quel que soit le système de fichiers utilisé.

4.1. Créer un système de fichiers ext3

Procédure 4.1. Créer un système de fichiers ext3

- Formater la partition ou le volume LVM avec le système de fichiers ext3 en utilisant

mkfs. - Étiqueter le système de fichiers en utilisant

e2label.

/dev/sda8, exécuter les commandes suivantes :

mkfs -t ext3 -U 7cd65de3-e0be-41d9-b66d-96d749c02da7 /dev/sda8 tune2fs -U 7cd65de3-e0be-41d9-b66d-96d749c02da7 /dev/sda8

# mkfs -t ext3 -U 7cd65de3-e0be-41d9-b66d-96d749c02da7 /dev/sda8

# tune2fs -U 7cd65de3-e0be-41d9-b66d-96d749c02da7 /dev/sda84.2. Conversion vers un système de fichiers ext3

tune2fs convertit un système de fichiers ext2 en ext3.

Note

e2fsck afin de vérifier votre système de fichiers avant et après avoir utilisé tune2fs. Avant d'essayer de convertir ext2 en ext3, veuillez effectuer des copies de sauvegarde de tous les systèmes de fichiers au cas ou une erreur se produirait.

ext2 en système de fichiers ext3, connectez-vous en tant que root et saisissez la commande suivante dans une fenêtre de terminal :

tune2fs -j block_device

# tune2fs -j block_devicedf pour afficher les systèmes de fichiers montés.

4.3. Rétablir un système de fichiers Ext2

/dev/mapper/VolGroup00-LogVol02

Procédure 4.2. Rétablir depuis ext3 vers ext2

- Démonter la partition en vous connectant en tant que root et en saisissant :

umount /dev/mapper/VolGroup00-LogVol02

# umount /dev/mapper/VolGroup00-LogVol02Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Modifier le type du système de fichiers en ext2 en saisissant la commande suivante :

tune2fs -O ^has_journal /dev/mapper/VolGroup00-LogVol02

# tune2fs -O ^has_journal /dev/mapper/VolGroup00-LogVol02Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Vérifier si la partition contient des erreurs en saisissant la commande suivante :

e2fsck -y /dev/mapper/VolGroup00-LogVol02

# e2fsck -y /dev/mapper/VolGroup00-LogVol02Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Puis monter la partition à nouveau en tant que système de fichiers ext2 en saisissant :

mount -t ext2 /dev/mapper/VolGroup00-LogVol02 /mount/point

# mount -t ext2 /dev/mapper/VolGroup00-LogVol02 /mount/pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow Dans la commande ci-dessus, remplacer /mount/point par le point de montage de la partition.Note

Si un fichier.journalexiste au niveau root de la partition, supprimez-le.

/etc/fstab, sinon l'autre type de système de fichiers sera rétabli après un démarrage.

Chapitre 5. Le système de fichiers Ext4

Note

fsck. Pour obtenir des informations supplémentaires, veuillez consulter le Chapitre 4, Système de fichiers Ext3.

- Fonctionnalités principales

- Ext4 utilise des extensions (contrairement au schéma de mappage de blocs traditionnellement utilisé par ext2 et ext3), ce qui améliore les performances lors de l'utilisation de fichiers de grande taille, et réduit les en-têtes des métadonnées des fichiers de grande taille. En outre, ext4 étiquette également les groupes de blocs et les sections de tables d'inodes en conséquence, ce qui leur permet d'être ignorés pendant les vérifications de systèmes de fichiers. Ceci permet d'effectuer des vérifications de systèmes de fichiers plus rapides, qui deviendront de plus en plus avantageuses au fur et à mesure que la taille du système de fichiers augmente.

- Fonctionnalités d'allocation

- Le système de fichiers ext4 offre les schémas d'allocation suivants :

- La pré-allocation persistante

- L'allocation différée

- L'allocation multi-blocs

- L'allocation par entrelacement

À cause de l'allocation différée, et dû à d'autres optimisations des performances, le comportement d'ext4 lors de l'écriture sur disque est différent d'ext3. Avec ext4, lorsqu'un programme est écrit sur le système de fichiers, il n'est pas garanti que ce soit effectivement sur disque à moins que le programme n'exécute un appelfsync()après.Par défaut, ext3 force automatiquement les fichiers récemment créés sur le disque de manière quasi immédiate, même sansfsync(). Ce comportement cache les bogues des programmes qui n'ont pas utiliséfsync()afin de s'assurer que les données écrites l'étaient sur disque. Contrairement à cela, le système de fichiers ext4 attend souvent plusieurs secondes pour écrire les changements sur le disque, lui permettant de combiner et de réarranger les écritures pour offrir de meilleures performances qu'ext3.Avertissement

Contrairement à ext3, le système de fichiers ext4 ne force pas les données sur disque lors des enregistrements de transactions. Ainsi, des écritures mises en mémoire tampon mettent plus longtemps pour être vidées sur le disque. Quant aux systèmes de fichiers, veuillez utiliser des appels d'intégrité de données, tels quefsync(), afin de vous assurer que les données soient effectivement écrites sur un stockage permanent. - Autres fonctionnalités Ext4

- Le système de fichiers ext4 prend également en charge :

- Les attributs étendus (

xattr) — Ceux-ci permettent au système d'associer plusieurs noms et paires de valeurs supplémentaires par fichier. - Journalisation de quotas — Ceci permet d'éviter le besoin de longues vérifications de la cohérence des quotas après une panne.

Note

Le seul mode de journalisation pris en charge sur ext4 estdata=ordered(par défaut). - Horodatage subsecond — Ceci donne la deuxième décimale des secondes à l'horodatage.

5.1. Créer un système de fichiers Ext4

mkfs.ext4. En général, les options par défaut sont optimales pour la plupart des scénarios d’utilisation :

mkfs.ext4 /dev/device

# mkfs.ext4 /dev/deviceExemple 5.1. Sortie de la commande mkfs.ext4

mkfs.ext4 choisit une géométrie optimale. Ceci peut également s'appliquer à certains types de matériel RAID qui exportent des informations sur la géométrie au système d'exploitation.

-E de mkfs.ext4 (c'est-à-dire les options de système de fichiers étendues) avec les sous-options suivantes :

- stride=value

- Spécifie la taille du bloc RAID.

- stripe-width=value

- Spécifie le nombre de disques de données dans un périphérique RAID, ou le nombre d'unités d'entrelacement dans l'entrelacement.

value » doit être spécifiée en unités de bloc de système de fichiers. Par exemple, pour créer un système de fichiers avec un stride de 64k (c'est-à-dire 16 x 4096) sur un système de fichiers de blocs de 4k, veuillez utiliser la commande suivante :

mkfs.ext4 -E stride=16,stripe-width=64 /dev/device

# mkfs.ext4 -E stride=16,stripe-width=64 /dev/deviceman mkfs.ext4.

Important

tune2fs pour activer certaines fonctionnalités ext4 sur des systèmes de fichiers ext3, et d'utiliser le pilote ext4 pour monter un système de fichiers ext3. Cependant, ces actions ne sont pas prises en charge sur Red Hat Enterprise Linux 7 car elles n'ont pas été totalement testées. À cause de cela, Red Hat ne peut pas garantir de performance cohérente ou de comportement prévisible pour les systèmes de fichiers ext3 convertis ou montés de cette manière.

5.2. Monter un système de fichiers Ext4

mount /dev/device /mount/point

# mount /dev/device /mount/pointacl active les listes de contrôle d'accès (« ACL »), tandis que le paramètre user_xattr active les attributs étendus d'utilisateur. Pour activer les deux options, veuillez utiliser leurs paramètres respectifs avec -o, comme suit :

mount -o acl,user_xattr /dev/device /mount/point

# mount -o acl,user_xattr /dev/device /mount/pointdata_err=abort peut être utilisée pour abandonner le journal si une erreur a lieu dans les données d'un fichier.

mount -o data_err=abort /dev/device /mount/point

# mount -o data_err=abort /dev/device /mount/pointtune2fs permet également aux administrateurs de définir les options de montage par défaut dans le superbloc du système de fichiers. Pour obtenir des informations supplémentaires, veuillez consulter man tune2fs.

Barrières d'écriture

nobarrier, comme suit :

mount -o nobarrier /dev/device /mount/point

# mount -o nobarrier /dev/device /mount/pointAperçu technologique de Direct Access (DAX)

Direct Access (DAX) fournit, en tant qu'aperçu technologique sur les systèmes de fichiers ext4 et XFS, un moyen pour une application de mapper directement la mémoire persistante dans son espace d'adresse. Pour utiliser DAX, un système doit posséder une certaine forme de mémoire persistante disponible, sous forme d'un ou de plusieurs modules Non-Volatile Dual In-line Memory Modules (NVDIMMs), et un système de fichiers supportant DAX doit être créé sur les NVDIMM(s). De plus, le système de fichiers doit être monté avec l'option de montage dax. Ensuite, un mmap de fichier de système de fichier monté-dax résulte en mappage direct de stockage dans l'espace d'adresse de l'application.

5.3. Redimensionner un système de fichiers Ext4

resize2fs :

resize2fs /mount/device size

# resize2fs /mount/device sizeresize2fs peut également réduire la taille d'un système de fichiers ext4 non monté :

resize2fs /dev/device size

# resize2fs /dev/device sizeresize2fs lit la taille de bloc du système de fichiers en unités, à moins qu'un suffixe indiquant une unité particulière ne soit utilisé. Les suffixes suivants indiquent des unités particulières :

s— secteurs de 512 octets sectorsK— kilooctetsM— mégaoctetsG— gigaoctets

Note

resize2fs s'étend automatiquement pour remplir tout l'espace disponible du conteneur, habituellement un volume ou une partition logique.

man resize2fs.

5.4. Sauvegarde des systèmes de fichiers ext2/3/4

Procédure 5.1. Exemple de sauvegarde des systèmes de fichiers ext2/3/4

- Toutes les données doivent être sauvegardées avant de tenter les opérations de restauration. Les sauvegardes de données doivent être effectuées régulièrement. En plus des données, il y a des informations de configuration qui doivent être sauvegardées, y compris

/etc/fstabet la sortie defdisk -l. Exécuter un sosreport/sysreport capturera cette information et est fortement conseillé.Copy to Clipboard Copied! Toggle word wrap Toggle overflow Dans cet exemple, nous allons utiliser la partition/dev/sda6pour sauvegarder des fichiers de sauvegarde, et nous assumons que/dev/sda6est monté sur le fichier/backup-files. - Si la partition sauvegardée est dans une partition de système d'exploitation, démarrez votre système en mode Single User. Cette étape n'est pas utile dans les cas de partitions de données normales.

- Utiliser la commande

dumppour sauvegarder le contenu des partitions :Note

- Si le système est en cours d'exécution depuis un bon moment, il est conseillé d'exécuter

e2fscksur les partitions avant la sauvegarde. dumpne doit pas être utilisé sur un système de fichiers monté et à forte charge car des versions corrompues de fichiers pourraient être sauvegardées. Ce problème a été soulevé dans dump.sourceforge.net.Important

Quand on sauvegarde des partitions de système d'exploitation, la partition doit être dé-montée.Bien qu'il soit possible de sauvegarder une partition de données ordinaire montée, il vaut mieux la dé-monter si possible. Si la partition de données est montée, les résultats de la sauvegarde sont imprévisibles.

dump -0uf /backup-files/sda1.dump /dev/sda1 dump -0uf /backup-files/sda2.dump /dev/sda2 dump -0uf /backup-files/sda3.dump /dev/sda3

# dump -0uf /backup-files/sda1.dump /dev/sda1 # dump -0uf /backup-files/sda2.dump /dev/sda2 # dump -0uf /backup-files/sda3.dump /dev/sda3Copy to Clipboard Copied! Toggle word wrap Toggle overflow Si vous souhaitez effectuer une sauvegarde à distance, vous pourrez utiliser ssh ou bien vous pourrez configurer une connexion sans mot de passe.Note

Si vous utilisez une redirection standard, l'option « -f » devra être passée séparément.dump -0u -f - /dev/sda1 | ssh root@remoteserver.example.com dd of=/tmp/sda1.dump

# dump -0u -f - /dev/sda1 | ssh root@remoteserver.example.com dd of=/tmp/sda1.dumpCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.5. Restaurer un système de fichiers ext2/3/4

Procédure 5.2. Exemple de restauration d'un système de fichiers ext2/3/4

- Si vous restaurez une partition de système d'exploitation, démarrez votre système en mode Rescue. Cette étape n'est pas requise pour les partitions de données ordinaires.

- Reconstruire sda1/sda2/sda3/sda4/sda5 à l'aise de la commande

fdisk.Note

Si nécessaire, créer des partitions qui puissent contenir les systèmes de fichiers restaurés. Les nouvelles partitions doivent être suffisamment grandes pour pouvoir contenir les données restaurées. Il est important d'avoir les bons numéros de début et de fin ; ce sont les numéros de secteurs de début et de fin des partitions. - Formater les partitions de destination en utilisant la commande

mkfs, comme montré ci-dessous.Important

NE PAS formater/dev/sda6dans l'exemple ci-dessus car il sauvegarde les fichiers de sauvegarde.mkfs.ext3 /dev/sda1 mkfs.ext3 /dev/sda2 mkfs.ext3 /dev/sda3

# mkfs.ext3 /dev/sda1 # mkfs.ext3 /dev/sda2 # mkfs.ext3 /dev/sda3Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Si vous créez des nouvelles partitions, rénommez toutes les partitions pour qu'elles puissent correspondre au fichier

fstab. Cette étape n'est pas utile si les partitions ne sont pas créées à nouveau.e2label /dev/sda1 /boot1 e2label /dev/sda2 / e2label /dev/sda3 /data mkswap -L SWAP-sda5 /dev/sda5

# e2label /dev/sda1 /boot1 # e2label /dev/sda2 / # e2label /dev/sda3 /data # mkswap -L SWAP-sda5 /dev/sda5Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Préparer les répertoires de travail.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Restaurer les données.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Si vous souhaitez restaurer à partir d'un hôte éloigné ou d'un fichier de sauvegarde d'un hôte éloigné, utiliser ssh ou rsh. Vous devrez configurer une connexion sans mot de passe pour les exemples suivants :Connectez-vous à 10.0.0.87, et restaurez sda1 à partir du fichier local sda1.dump :ssh 10.0.0.87 "cd /mnt/sda1 && cat /backup-files/sda1.dump | restore -rf -"

# ssh 10.0.0.87 "cd /mnt/sda1 && cat /backup-files/sda1.dump | restore -rf -"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Connectez-vous à 10.0.0.87, et restaurez sda1 à partir du fichier distant 10.66.0.124 sda1.dump :ssh 10.0.0.87 "cd /mnt/sda1 && RSH=/usr/bin/ssh restore -r -f 10.66.0.124:/tmp/sda1.dump"

# ssh 10.0.0.87 "cd /mnt/sda1 && RSH=/usr/bin/ssh restore -r -f 10.66.0.124:/tmp/sda1.dump"Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Démarrez à nouveau.

5.6. Autres utilitaires du système de fichiers Ext4

- e2fsck

- Utilisé pour réparer un système de fichiers ext4. Cet outil vérifie et répare un système de fichiers ext4 plus efficacement qu'ext3, grâce aux mises à jour apportées à la structure de disque ext4.

- e2label

- Change l'étiquette sur un système de fichiers ext4. Cet outil fonctionne également sur les systèmes de fichiers ext2 et ext3.

- quota

- Contrôle et effectue des rapports sur l'utilisation de l'espace disque (les blocs) et des fichiers (inodes) par les utilisateurs et les groupes sur un système de fichiers ext4. Pour obtenir des informations sur l'utilisation de

quota, veuillez consulterman quotaet la Section 16.1, « Configurer les quotas de disques ». - fsfreeze

- Pour suspendre l'accès à un système de fichiers, utiliser la commande

# fsfreeze -f mount-pointpour le geler, et# fsfreeze -u mount-pointpour le dégeler. Cela stoppe l'accès au système de fichiers et crée une image stable sur disque.Note

Il faut utiliserfsfreezepour les pilotes de mappage de périphériques.Pour plus d'informations, voir la page manfsfreeze(8).

tune2fs peut également ajuster des paramètres de systèmes de fichiers configurables pour les systèmes de fichiers ext2, ext3, et ext4. En outre, les outils suivants sont aussi utiles pour le débogage et l'analyse des système de fichiers ext4 :

- debugfs

- Débogue les systèmes de fichiers ext2, ext3, ou ext4.

- e2image

- Enregistre les métadonnées critiques des systèmes de fichiers ext2, ext3, ou ext4 sur un fichier.

man respectives.

Chapitre 6. Le système de fichiers XFS

- Fonctionnalités principales

- XFS prend en charge la journalisation de métadonnées, ce qui facilite une récupération après incident plus rapide. Le système de fichiers XFS peut aussi être défragmenté et élargi alors qu'il est monté et actif. En outre, Red Hat Enterprise Linux 7 prend en charge les utilitaires de sauvegarde et de restauration spécifiques à XFS.

- Fonctionnalités d'allocation

- XFS offre les schémas d'allocation suivants :

- Allocation basée sur extensions

- Politiques d'allocation par entrelacement

- L'allocation différée

- Pré-allocation de l'espace

L'allocation différée et les autres optimisations des performances affectent XFS de la même manière qu'ext4. Autrement dit, les écritures d'un programme sur un système de fichiers XFS ne garantissent pas d'être sur disque à moins que le programme n'effectue un appelfsync()par la suite.Pour obtenir des informations supplémentaires sur les implications de l'allocation différée sur un système de fichiers (ext4 et XFS), veuillez consulter les Fonctionnalités de l'allocation dans le Chapitre 5, Le système de fichiers Ext4.Note

Créer ou étendre des fichiers échoue occasionnellement avec un échec d'écriture ENOSPC inattendu même si le disque semble insuffisant. Cela s'explique par le design de XFS qui est basé sur la performance. Dans la pratique, ce n'est pas un problème car cela ne survient que si l'espace restant n'est que dans quelques blocs. - Autres fonctionnalités XFS

- Le système de fichiers XFS prend également en charge ce qui suit :

- Attributs étendus (

xattr) - Ceci permet au système d'associer plusieurs paires nom/valeur supplémentaires par fichiers. Activé par défaut.

- Journalisation de quotas

- Ceci permet d'éviter le besoin de longues vérifications de cohérence des quotas après une panne.

- Quotas de projets/répertoires

- Ceci permet les restrictions de quotas sur une arborescence de répertoires.

- Horodatage subsecond

- Ceci permet à l'horodatage de donner la deuxième décimale des secondes.

- Attributs étendus (

- Le comportement par défaut

atimeestrelatime Relatimeest pour XFS par défaut. N'a presque pas de temps de latence par rapport ànoatimetout en conservant des valeursatimesaines.

6.1. Créer un système de fichiers XFS

mkfs.xfs /dev/device. En général, les options par défaut sont optimales pour un usage commun.

mkfs.xfs sur un périphérique bloc contenant un système de fichiers, veuillez utiliser l'option -f pour forcer le remplacement de ce système de fichiers.

Exemple 6.1. Sortie de la commande mkfs.xfs

mkfs.xfs :

Note

xfs_growfs (veuillez consulter Section 6.4, « Augmenter la taille d'un système de fichiers XFS »).

mkfs.xfs choisit une géométrie optimale. Ceci peut également s'appliquer à certains types de matériel RAID qui exportent des informations sur la géométrie au système d'exploitation.

mkfs (pour ext3, ext4, et xfs) utilisera cette géométrie automatiquement. Si la géométrie de tranches n'est pas détectée, il sera possible de la spécifier automatiquement à un moment mkfs par les options suivantes :

- su=value

- Spécifie une unité d'entrelacement ou une taille de morceau RAID. La valeur

valuedoit être indiquée en octets, avec un suffixe optionnelk,m, oug. - sw=value

- Spécifie le nombre de disques de données dans un périphérique RAID, ou le nombre d'unités d'entrelacement dans l'entrelacement.

mkfs.xfs -d su=64k,sw=4 /dev/device

# mkfs.xfs -d su=64k,sw=4 /dev/deviceman mkfs.xfs et Red Hat Enterprise Linux Performance Tuning Guide, chapitre Basic Tuning for XFS.

6.2. Monter un système de fichiers XFS

mount /dev/device /mount/point

# mount /dev/device /mount/pointNote

Barrières d'écriture

nobarrier :

mount -o nobarrier /dev/device /mount/point

# mount -o nobarrier /dev/device /mount/pointAperçu technologique de Direct Access (DAX)

Direct Access (DAX) fournit, en tant qu'aperçu technologique sur les systèmes de fichiers ext4 et XFS, un moyen pour une application de mapper directement la mémoire persistante dans son espace d'adresse. Pour utiliser DAX, un système doit posséder une certaine forme de mémoire persistante disponible, sous forme d'un ou de plusieurs modules Non-Volatile Dual In-line Memory Modules (NVDIMMs), et un système de fichiers supportant DAX doit être créé sur les NVDIMM(s). De plus, le système de fichiers doit être monté avec l'option de montage dax. Ensuite, un mmap de fichier de système de fichier monté-dax résulte en mappage direct de stockage dans l'espace d'adresse de l'application.

6.3. Gestion des quotas XFS

noenforce ; ceci permettra d'effectuer des rapport d'utilisation sans appliquer de limite. Les options de montage de quotas valides incluent :

uquota/uqnoenforce- Quotas d'utilisateursgquota/gqnoenforce- Quotas de groupespquota/pqnoenforce- Quotas de projets

xfs_quota peut être utilisé pour définir les limites et effectuer un rapport sur l'utilisation du disque. Par défaut, xfs_quota est exécuté de manière interactive et dans le mode de base. Les sous-commandes du mode de base rapportent simplement l'usage et sont disponibles à tous les utilisateurs. Les sous-commandes xfs_quota de base incluent :

- quota username/userID

- Afficher l'utilisation et les limites pour le nom d'utilisateur

usernamedonné ou l'ID numériqueuserIDdonné - df

- Afficher le compte des blocs et inodes disponibles et utilisés

xfs_quota possède également un mode expert. Les sous-commandes de ce mode permettent la configuration des limites, et sont uniquement disponibles aux utilisateurs possédant des privilièges élevés. Pour utiliser les sous-commandes du mode expert de manière interactive, veuillez exécuter xfs_quota -x. Les sous-commandes du mode expert incluent :

- report /path

- Rapport des informations sur les quotas d'un système de fichiers particulier

- limit

- Modifier les limites de quota.

help.

-c, avec -x pour les sous-commandes du mode expert.

Exemple 6.2. Afficher un exemple de rapport de quotas

/home (sur /dev/blockdevice), veuillez utiliser la commande xfs_quota -x -c 'report -h' /home. Ceci affichera une sortie similaire à la suivante :

john (dont le répertoire d'acceuil est /home/john), veuillez utiliser la commande suivante :

xfs_quota -x -c 'limit isoft=500 ihard=700 john' /home/

# xfs_quota -x -c 'limit isoft=500 ihard=700 john' /home/limit reconnaît les cibles en tant qu'utilisateurs. Lors de la configuration des limites d'un groupe, veuillez utiliser l'option -g (comme dans l'exemple précédent). De la même manière, veuillez utiliser -p pour les projets.

bsoft ou bhard au lieu de isoft ou ihard.

Exemple 6.3. Définir une limite douce (« soft ») et une limite dure (« hard »)

accounting sur le système de fichiers /target/path, veuillez utiliser la commande suivante :

xfs_quota -x -c 'limit -g bsoft=1000m bhard=1200m accounting' /target/path

# xfs_quota -x -c 'limit -g bsoft=1000m bhard=1200m accounting' /target/pathNote

bsoft et bhard comptent par octets.

Important

rtbhard/rtbsoft) sont décrits dans man xfs_quota comme étant des unités valides lors du paramétrage de quotas, le sous-volume en temps réel n'est pas activé dans cette version. Ainsi, les options rtbhard et rtbsoft ne sont pas applicables.

Paramétrer des limites de projets

/etc/projects. Les noms de projets peuvent être ajoutés à /etc/projectid pour lier les ID de projets aux noms de projets. Une fois qu'un projet est ajouté à /etc/projects, veuillez initialiser son répertoire de projet en utilisant la commande suivante :

xfs_quota -x -c 'project -s projectname' project_path

# xfs_quota -x -c 'project -s projectname' project_pathxfs_quota -x -c 'limit -p bsoft=1000m bhard=1200m projectname'

# xfs_quota -x -c 'limit -p bsoft=1000m bhard=1200m projectname'quota, repquota, et edquota) peuvent également être utilisés pour manipuler les quotas XF. Cependant, ces outils ne peuvent pas être utilisés avec les quotas des projets XFS.

Important

xfs_quota sur tous les autres outils disponibles.

man xfs_quota, man projid(5), et man projects(5).

6.4. Augmenter la taille d'un système de fichiers XFS

xfs_growfs :

xfs_growfs /mount/point -D size

# xfs_growfs /mount/point -D size-D size permet d'augmenter la taille du système de fichiers à la taille size spécifiée (exprimée en nombre de blocs de système de fichier). Sans l'option -D size, xfs_growfs augmentera la taille du système de fichiers à la taille maximum prise en charge par le périphérique.

-D size, assurez-vous que la taille du périphérique bloc sous-jacent sera appropriée pour contenir le système de fichiers. Veuillez utiliser les méthodes correctes de redimensionnement pour les périphériques bloc affectés.

Note

man xfs_growfs.

6.5. Réparer un système de fichiers XFS

xfs_repair:

xfs_repair /dev/device

# xfs_repair /dev/devicexfs_repair est hautement évolutif et a également été conçu pour réparer des systèmes de fichiers de très grande taille avec de nombreux inodes de manière efficace. Contrairement aux autres systèmes de fichiers Linux, xfs_repair n'est pas exécuté lors du démarrage, même lorsqu'un système de fichiers XFS n'a pas été monté correctement. En cas de démontage incorrect, xfs_repair rediffuse simplement le journal pendant le montage, s'assurant ainsi d'un système de fichiers cohérent.

Avertissement

xfs_repair ne peut pas réparer un système de fichiers XFS avec un journal endommagé. Pour supprimer le journal, montez et démontez le système de fichiers. Si le journal est corrompu et qu'il ne peut pas être réutilisé, veuillez utiliser l'option -L (« forcer la mise à zéro du journal ») pour supprimer le journal, c'est-à-dire xfs_repair -L /dev/device. Prenez note que cette opération peut provoquer une corruption ou des pertes de données supplémentaires.

man xfs_repair.

6.6. Suspendre un système de fichier XFS

xfs_freeze. La suspension d'activités d'écriture permet l'utilisation des clichés de périphériques basés matériel pour capturer le système de fichiers dans un état cohérent.

Note

xfs_freeze est fourni par le paquet xfsprogs uniquement disponbible sur x86_64.

xfs_freeze -f /mount/point

# xfs_freeze -f /mount/pointxfs_freeze -u /mount/point

# xfs_freeze -u /mount/pointxfs_freeze pour suspendre le système de fichiers avant tout. Au contraire, les outils de gestion LVM suspendront automatiquement le système de fichiers XFS avant de prendre le cliché.

man xfs_freeze.

6.7. Sauvegarde et restauration des systèmes de fichiers XFS

xfsdump et xfsrestore.

xfsdump. Red Hat Enterprise Linux 7 prend en charge les sauvegardes sur lecteurs de bande ou images fichiers normales, et permet également d'écrire plusieurs vidages sur le même lecteur. L'utilitaire xfsdump permet aussi à un vidage de s'étendre sur plusieurs lecteurs, même si un vidage peut être écrit sur un fichier normal. En outre, xfsdump prend en charge les sauvegardes incrémentales, et peut exclure des fichiers d'une sauvegarde en utilisant la taille, une sous-arborescence, ou des indicateurs d'inodes pour les filtrer.

xfsdump utilise des niveaux de vidage pour déterminer un vidage de base auquel un vidage particulier est relatif. L'option -l spécifie un niveau de vidage (0-9). Pour effectuer une copie de sauvegarde complète, veuillez effectuer un vidage de niveau 0 sur le système de fichiers (c'est-à-dire /path/to/filesystem), comme suit :

xfsdump -l 0 -f /dev/device /path/to/filesystem

# xfsdump -l 0 -f /dev/device /path/to/filesystemNote

-f spécifie une destination pour la sauvegarde. Par exemple, la destination /dev/st0 est normalement utilisée pour les lecteurs de bande. Une destination xfsdump peut être un lecteur de bande, un fichier normal, ou un périphérique de bande distant.

xfsdump -l 1 -f /dev/st0 /path/to/filesystem

# xfsdump -l 1 -f /dev/st0 /path/to/filesystemxfsrestore restaure les systèmes de fichiers depuis les vidages produits par xfsdump. L'utilitaire xfsrestore possède deux modes : un mode par défaut simple, et un mode cumulatif. Les vidages spécifiques sont identifiés par ID de session ou par étiquette de session. Ainsi, restaurer un vidage requiert son ID ou étiquette de session correspondant. Pour afficher les ID et étiquettes de session de tous les vidages (complets et incrémentaux), veuillez utiliser l'option -I :

xfsrestore -I

# xfsrestore -IExemple 6.4. ID et étiquettes de session de tous les vidages

Mode simple de xfsrestore

session-ID), veuillez le restaurer complètement sur /path/to/destination en utilisant :

xfsrestore -f /dev/st0 -S session-ID /path/to/destination

# xfsrestore -f /dev/st0 -S session-ID /path/to/destinationNote

-f spécifie l'emplacement du vidage, tandis que l'option -S ou -L indique le vidage particulier à restaurer. L'option -S est utilisée pour spécifier un ID de session, tandis que l'option -L est utilisée pour les étiquettes de session. L'option -I affiche les étiquettes et ID de session de chaque vidage.

Mode cumulatif de xfsrestore

xfsrestore permet la restauration de systèmes de fichier à partir d'une sauvegarde incrémentale particulière, par exemple, du niveau 1 au niveau 9. Pour restaurer un système de fichiers à partir d'une sauvegarde incrémentale, veuillez simplement ajouter l'option -r :

xfsrestore -f /dev/st0 -S session-ID -r /path/to/destination

# xfsrestore -f /dev/st0 -S session-ID -r /path/to/destinationOpération interactive

xfsrestore permet également à des fichiers particuliers d'un vidage d'être extraits, ajoutés ou supprimés. Pour utiliser xfsrestore de manière interactive, veuillez utiliser l'option -i, comme suit :

xfsrestore -f /dev/st0 -i /destination/directory

xfsrestore termine de lire le périphérique spécifié. Les commandes de cette boîte de dialogue incluent cd, ls, add, delete, et extract ; pour obtenir une liste complète des commandes, veuillez utiliser help.

man xfsdump et man xfsrestore.

6.8. Autres utilitaires des systèmes de fichiers XFS

- xfs_fsr

- Utilisé pour défragmenter les systèmes de fichiers XFS montés. Lorsqu'invoqué sans arguments,

xfs_fsrdéfragmente tous les fichiers normaux dans tous les systèmes de fichiers XFS montés. Cet utilitaire permet également aux utilisateurs de suspendre une défragmentation à une heure spécifiée et de la reprendre au même endroit ultérieurement.En outre,xfs_fsrpermet également la défragmentation d'un seul fichier, comme dansxfs_fsr /path/to/file. Red Hat recommande d'éviter de défragmenter un système de fichiers entier par défaut. La défragmentation du système dans son entier pourrait entraîner un effet secondaire de fragmentation d'espace libre. - xfs_bmap

- Imprime la carte des blocs de disque utilisés par les fichiers dans un système de fichiers XFS. Cette carte répertorie chaque extension utilisés par un fichier spécifié, ainsi que les régions du fichiers n'offrant pas de bloc correspondant (c'est-à-dire, des trous).

- xfs_info

- Imprime les informations du système de fichiers XFS.

- xfs_admin

- Modifie les paramètres d'un système de fichiers XFS. L'utilitaire

xfs_adminpeut uniquement modifier les paramètres de périphériques ou systèmes de fichiers non montés. - xfs_copy

- Copie la totalité du contenu d'un système de fichiers XFS entier sur une ou plusieurs cibles en parallèle.

- xfs_metadump

- Copie les métadonnées du système de fichiers XFS sur un fichier. Red Hat permet d'utiliser

xfs_metadumppour copier les systèmes de fichiers non montés, en lecture seule, ou gelés ou suspendus ; sinon les vidages générés pourraient être corrompus ou incohérents. - xfs_mdrestore

- Restaure une image metadump XFS (générée avec

xfs_metadump) sur une image de système de fichiers. - xfs_db

- Débogue un système de fichiers XFS.

man respectives.

6.9. Migration de ext4 à XFS

6.9.1. Commandes utilisées avec ext3 et ext4 comparé à XFS

| Tâche | ext3/4 | XFS |

|---|---|---|

| Créez un système de fichiers | mkfs.ext4 or mkfs.ext3 | mkfs.xfs |

| Vérification du système de fichiers (fsck) | e2fsck | xfs_repair |

| Redimensionner un système de fichiers | resize2fs | xfs_growfs |

| Enregistre une image de système de fichiers | e2image | xfs_metadump et xfs_mdrestore |

| Libeller ou ajuster un système de fichiers | tune2fs | xfs_admin |

| Sauvegarder un système de fichiers | dump et restore | xfsdump et xfsrestore |

| Tâche | ext4 | XFS |

|---|---|---|

| Quota | quota | xfs_quota |

| Mappage de fichiers | filefrag | xfs_bmap |

6.9.2. Différences comportementales et administratives entre Ext3/4 et XFS

- Réparation du système de fichiers

- Ext3/4 exécute

e2fsckdans l'espace utilisateur au démarrage pour récupérer le journal si besoin. XFS, en revanche, procède à la récupération du journal de l'espace noyau au montage. Un script shellfsck.xfsest fourni, mais il ne sert pas à grand chose sauf en tant que prérequis d'initscript.Quand une réparation de système de fichier XFS ou qu'une vérification est requise, utiliser la commandexfs_repair. Utiliser l'option-npour une vérification en lecture-seule.La commandexfs_repairne fonctionnera pas sur un système de fichiers qui a un journal endommagé. Pour réparer un tel fichier, les commandesmountetunmountdoivent être exécutées pour commencer afin d'exécuter le journal à nouveau. Si le journal est corrompu ou ne peut pas être exécuté à nouveau, l'option-Lpourra être utilisée pour neutraliser le journal.Pour plus d'informations sur la réparation du système de fichiers des systèmes de fichiers XFS, consulter Section 11.2.2, « XFS » - Comportement des erreurs de métadonnées

- Le système de fichiers ext2/3 a un comportement configurable quand des erreurs de métadonnées surviennent, et que le comportement par défaut est tout simplement de continuer. Quand XFS rencontre une erreur de métadonnnées non récupérable, il ferme le système de fichiers et renvoie comme message d'erreur

EFSCORRUPTED. Les journaux système contiendront des détails sur les erreurs rencontrées et vous conseilleront d'exécuterxfs_repairsi besoin est. - Quotas

- Les quotas XFS n'ont pas d'option pour remonter. L'option

-o quotadoit être spécifiée sur le point de montage de départ pour que les quotas puissent prendre effet.Bien que les outils standards du package des quotas puisse effectuer des tâches administratives de base (comme setquota et repquota), l'outil xfs_quota peut être utilisé pour des fonctions spécifiques XFS, comme l'administration des quotas d'un projet.La commandequotacheckn'a aucun effet sur un système de fichiers XFS. La première fois que le compteur de quotas est activé, XFS procède à unquotacheckinterne automatiquement. Comme les métadonnées de quota XFS représentent un objet de métadonnées journalisées de première classe, le système de fichiers sera toujours consistent jusqu'à ce que les quotas soient désactivés manuellement. - Redimensionnement du système de fichiers

- Le système de fichiers XFS n'a pas de fonctionnalité qui puisse permettre de réduire un système de fichiers. Les systèmes de fichiers XFS peuvent être agrandis en ligne à l'aide de la commande

xfs_growfs. - Les numéros d'inodes

- Pour les systèmes de fichiers supérieurs à 1T avec des inodes de 256 octets, ou de plus de 2T avec des inodes de 512 octets, les numéros d'inode XFS pourraient dépasser 2^32. Ces numéros d'inode élevés peuvent amener les appels de 32-bit à échouer avec le message

EOVERFLOW. En général, les applications doivent gérer des numéros d'inodes élevés, mais, si nécessaire, XFS devra être monté avec-o inode32pour appliquer les numéros d'inode inférieurs à 2^32.Note

Cela n'affectera pas les inodes déjà alloués avec des numéros de 64-bit.L'option change le comportement d'allocation et mène rapidement à un ENOSPC si aucun espace n'est disponible pour allouer des inodes dans les blocs de disques inférieurs. L'option inode32 ne devra pas être utilisée à moins qu'elle ne soit requise pour un environnement particulier. - Pré-allocation spéculative

- XFS utilise speculative preallocation pour allouer des blocs après EOF au fur et à mesure que les fichiers sont écrits. Cela permet d'éviter la fragmentation des fichiers liée aux charges de travail de flux d'écriture parallèles sur les serveurs NFS. Par défaut, cette pré-allocation augmente en fonction de la taille du fichier, et sera apparente dans la sorie "du". Si un fichier ayant une pré-allocation spéculative n'est pas modifié sous les 5 minutes, la pré-allocation sera abondonnée. Si l'inode est sortie du cache avant ce moment-là, la pré-allocation sera abandonnée quand l'inode sera récupérée.Si des problèmes ENOSPC apparaissent suite à une pré-allocation spéculative, un montant de pré-allocation prédéterminé pourra être spécifié par l'option de montage

-o allocsize=amount. - Outils de fragmentation

- La fragmentation est rarement un problème pour les systèmes de fichiers XFS pour des raison heuristiques et de comportement, comme les retardements d'allocation ou les préallocations spéculatives. Cependant, il existe des outils pour mesurer la fragmentation des systèmes de fichiers, ainsi que pour défragmenter les systèmes de fichiers. Leur utilisation n'est pas conseillée.Les tentatives de commande

xfs_db fragservent à distiller toutes les allocations de système de fichier en un nombre unique de fragmentations, exprimée en pourcentage. La sortie de la comand requiert une grande compétence pour en comprendre la signification. Par exemple, un facteur de fragmentation de 75 % indique uniquement une moyenne de 4 degrés par fichier. Pour cette raison, la sortie de frag de xfs_db n’est pas jugée utile, et une analyse plus attentive de tout problème de fragmentation est recommandée.Avertissement

La commandexfs_fsrpeut être utilisée pour défragmenter des fichiers individuels, ou tous les fichiers d'un système de fichiers. Cette dernière est particulièrement déconseillée car elle peut détruire l'emplacement des fichiers et risque de fragmenter l'espace libre.

Chapitre 7. Global File System 2

fsck sur un système de fichiers de très grande taille peut prendre longtemps et consommer beaucoup de mémoire. De plus, en cas de défaillance d'un disque ou d'un sous-système de disque, le temps de récupération sera limité par la vitesse de votre support de sauvegarde.

clvmd, qui est exécuté dans un cluster de Red Hat Cluster Suite. Le démon facilite l'utilisation de LVM2 pour gérer les volumes logiques à travers un cluster, permettant ainsi à tous les nœuds du cluster de partager les volumes logiques. Pour obtenir des informations sur le gestionnaire de volumes logiques LVM, veuillez consulter le guide de Red Hat Administration du gestionnaire de volumes logiques.

gfs2.ko implémente le système de fichiers GFS2 et est chargé dans les nœuds de cluster GFS2.

Chapitre 8. Network File System (NFS)

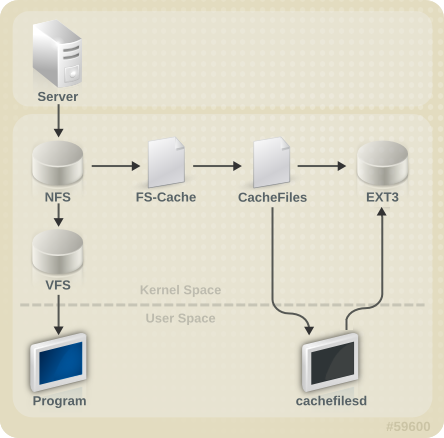

8.1. Fonctionnement NFS

rpcbind, prend en charge les ACL, et utilise les opérations stateful.

Note

rpcbind [1], lockd, and rpc.statd daemons. The rpc.mountd daemon is still required on the NFS server to set up the exports, but is not involved in any over-the-wire operations.

Note

'-p' pouvant définir le port, ce qui rend la configuration du pare-feu plus facile.

/etc/exports pour déterminer si le client a le droit d'accéder à un système de fichiers exporté. Une fois cette vérification effectuée, toutes les opérations des fichiers et répertoires seront disponibles pour l'utilisateur.

Important

rpc.nfsd permettent désormais la liaison vers tout port spécifié pendant le démarrage système. Cependant, ceci est prône aux erreurs si le port est indisponible, ou s'il est en conflit avec un autre démon.

8.1.1. Services requis

rpcbind. Pour partager ou monter les systèmes de fichiers NFS, les services suivants travaillent ensemble selon la version NFS implémentée :

Note

portmap a été utilisé pour mapper les numéros de programmes RPC à des combinaisons de numéros de port d'adresses IP dans des versions plus récentes de Red Hat Enterprise Linux. Ce service est désormais remplacé par rpcbind dans Red Hat Enterprise Linux 7 afin de permettre la prise en charge d'IPv6. Pour obtenir des informations supplémentaires sur ce changement, veuillez consulter les liens suivants :

- TI-RPC / prise en charge rpcbind : http://nfsv4.bullopensource.org/doc/tirpc_rpcbind.php

- Prise en charge IPv6 sur NFS : http://nfsv4.bullopensource.org/doc/nfs_ipv6.php

- nfs

servicectl start nfslance le serveur NFS et les processus RPC appropriés pour servir les requêtes des systèmes de fichiers NFS partagés.- nfslock

servicectl start nfs-lockactive un service obligatoire qui lance les processus RPC appropriés, ce qui permet aux clients NFS de verrouiller des fichiers sur le serveur.- rpcbind

rpcbindaccepte les réservations de ports des services RPC locaux. Ces ports sont ensuite mis à disponibilité (ou publicisés) afin que les services RPC à distance correspondants puissent y accéder.rpcbindrépond à des requêtes de service RPC et paramètre des connexions vers le service RPC requis. Ceci n'est pas utilisé avec NFSv4.

- rpc.mountd

- Ce processus est utilisé par un serveur NFS pour traiter les requêtes

MOUNTdes clients NFSv3. Il vérifie que le partage NFS requis est actuellement exporté par le serveur NFS, et que le client est autorisé à y accéder. Si la requête de montage est autorisée, le serveur rpc.mountd répond avec le statutSuccess(« Opération réussie ») et retourne l'identificateur de fichier «File-Handle» de ce partage NFS au client NFS. - rpc.nfsd

rpc.nfsdpermet de définir les versions et protocoles NFS explicites publicisés par le serveur. Celui-ci fonctionne avec le noyau Linux afin de répondre aux demandes des clients NFS, comme pour fournir des threads chaque fois qu'un client NFS se connecte. Ce processus correspond au servicenfs.- lockd

lockdest un thread du noyau qui peut être exécuté sur les clients et les serveurs. Il implémente le protocole NLM (« Network Lock Manager »), qui permet aux clients NFSv3 de verrouiller des fichiers sur le serveur. Il est lancé automatiquement à chaque fois que le serveur NFS est exécuté et à chaque fois qu'un système de fichiers NFS est monté.- rpc.statd

- Ce processus implémente le protocole RPC NSM (« Network Status Monitor »), qui notifie les clients NFS lorsqu'un serveur NFS est redémarré sans avoir tout d'abord été éteint correctement.

rpc.statdest automatiquement démarré par le servicenfslock, et ne requiert pas de configuration utilisateur. Ce protocole n'est pas utilisé avec NFSv4. - rpc.rquotad

- Ce processus fournit des informations sur le quota d'utilisateur des utilisateurs distants.

rpc.rquotadest automatiquement démarré par le servicenfset ne requiert pas de configuration utilisateur. - rpc.idmapd

rpc.idmapdfournit des appels ascendants client et serveur NFSv4, qui mappent simultanément les noms NFSv4 (chaînes sous le formatutilisateur@domaine) et les UID et GID locaux. Pour queidmapdpuisse fonctionner avec NFSv4, le fichier/etc/idmapd.confdoit être configuré. Au minimum, le paramètre « Domaine », qui définit le domaine de mappage NFSv4, doit être spécifié. Si le domaine de mappage NFSv4 est le même que le nom de domaine DNS, oubliez ce paramètre. Le client et le serveur doivent se mettre d'accord sur le domaine de mappage NFSv4 pour que le mappage d'ID fonctionne correctement.Note

Dans Red Hat Enterprise Linux 7, seul le serveur NFSv4 utiliserpc.idmapd. Le client NFSv4 utilisenfsidmapde l'imapper basé-keyring .nfsidmapest un programme autonome appelé par le noyau à la demande pour effectuer les mappages d'ID ; ce n'est pas un démon. S'il y a un problème avecnfsidmap, le client utilise alorsrpc.idmapd. Vous trouverez plus d'informations surnfsidmapdans la page man de nfsidmap.

8.2. pNFS

Note

-o v4.1

-o v4.1nfs_layout_nfsv41_files est automatiquement chargé sur le premier montage. L'entrée de montage de la sortie doit contenir minorversion=1. Veuillez utiliser la commande suivante pour vérifier que le module a bien été chargé :

lsmod | grep nfs_layout_nfsv41_files

$ lsmod | grep nfs_layout_nfsv41_files8.3. Configuration du client NFS

mount monte les partages NFS côté client. Son format est comme suit :

mount -t nfs -o options server:/remote/export /local/directory

# mount -t nfs -o options server:/remote/export /local/directory- options

- Liste d'options de montage séparées par des virgules. Veuillez consulter la Section 8.5, « Options de montage NFS courantes » pour obtenir des détails sur les options de montage NFS valides.

- server

- Nom d'hôte, adresse IP, ou nom de domaine complet du serveur exportant le système de fichiers que vous souhaitez monter

- /remote/export

- Système de fichiers ou répertoire en cours d'exportation du serveur, c'est-à-dire le répertoire que vous souhaitez monter

- /local/directory

- Emplacement du client où /remote/export est monté

mount nfsvers ou vers. Par défaut, mount utilisera NFSv4 avec mount -t nfs. Si le serveur ne prend pas en charge NFSv4, le client passera automatiquement à une version prise en charge par le serveur. Si l'option nfsvers/vers est utilisée pour passer une version particulière qui n'est pas prise en charge par le serveur, le montage échouera. Le type de système de fichiers nfs4 est également disponible pour des raisons d'héritage ; ceci est équivalent à exécuter mount -t nfs -o nfsvers=4 host:/remote/export /local/directory.

man mount pour davantage de détails.

/etc/fstab et le service autofs. Veuillez consulter la Section 8.3.1, « Monter des systèmes de fichiers NFS à l'aide de /etc/fstab » et Section 8.4, « autofs » pour obtenir davantage d'informations.

8.3.1. Monter des systèmes de fichiers NFS à l'aide de /etc/fstab

/etc/fstab file. The line must state the hostname of the NFS server, the directory on the server being exported, and the directory on the local machine where the NFS share is to be mounted. You must be root to modify the /etc/fstab file.

Exemple 8.1. Exemple de syntaxe