Guide de l'administrateur systèmes

Déploiement, configuration, et administration de Red Hat Enterprise Linux 7

Résumé

Note

Partie I. Configuration de base du système

Chapitre 1. Paramètres régionaux et configuration du clavier

/etc/locale.conf ou en utilisant l'utilitaire localectl. Ainsi, vous pouvez utiliser l'interface utilisateur graphique pour effectuer la tâche. Pour obtenir une description de la méthode, veuillez consulter le Guide d'installation Red Hat Enterprise Linux 7.

1.1. Définir les paramètres régionaux

/etc/locale.conf, qui est lu au début du démarrage par le démon systemd. Les paramètres régionaux configurés dans /etc/locale.conf sont hérités par chaque service ou utilisateur, à moins qu'un programme ou utilisateur individuel ne l'outrepasse.

/etc/locale.conf est une liste séparée par des lignes d'affectation de variables. Voici des paramètres allemands avec des messages en anglais dans /etc/locale.conf :

LANG=de_DE.UTF-8 LC_MESSAGES=C

LANG=de_DE.UTF-8

LC_MESSAGES=C

/etc/locale.conf, vous pouvez utiliser plusieurs autres options. Les plus courantes sont résumées dans Tableau 1.1, « Options configurables dans /etc/locale.conf ». Veuillez consulter la page du manuel locale(7) pour obtenir des informations détaillées sur ces options. Veuillez remarquer que l'option LC_ALL, qui représente toutes les options possibles, ne doit pas être configurée dans /etc/locale.conf.

| Option | Description |

|---|---|

| LANG | Fournit une valeur par défaut pour les paramètres régionaux. |

| LC_COLLATE | Modifie le comportement des fonctions qui comparent les chaînes dans l'alphabet local. |

| LC_CTYPE | Modifie le comportement des fonctions de gestion et de classification des caractères et les fonctions des caractères multioctets. |

| LC_NUMERIC | Décrit la manière par laquelle les chiffres sont habituellement imprimés, avec des détails tels que le point décimal versus la virgule décimale. |

| LC_TIME | Modifie l'affichage de l'heure actuelle, 24 heures versus 12 heures. |

| LC_MESSAGES | Détermine les paramètres régionaux utilisés pour les messages de diagnostique écrits dans la sortie d'erreur standard. |

1.1.1. Afficher le statut actuel

localectl peut être utilisée pour effectuer des requêtes et modifier les paramètres régionaux et les paramètres d'agencement du clavier. Pour afficher les paramètres actuels, veuilles utiliser l'option status :

localectl status

localectl statusExemple 1.1. Afficher le statut actuel

localectl status

System Locale: LANG=en_US.UTF-8

VC Keymap: us

X11 Layout: n/a

~]$ localectl status

System Locale: LANG=en_US.UTF-8

VC Keymap: us

X11 Layout: n/a

1.1.2. Répertorier les paramètres régionaux disponibles

localectl list-locales

localectl list-localesExemple 1.2. Répertorier les paramètres régionaux

1.1.3. Définir les paramètres régionaux

root :

localectl set-locale LANG=locale

localectl set-locale LANG=localelocalectl list-locales. La syntaxe ci-dessus peut également être utilisée pour configurer les paramètres de Tableau 1.1, « Options configurables dans /etc/locale.conf ».

Exemple 1.3. Modifier les paramètres régionaux par défaut

list-locales. Puis, en tant qu'utilisateur root, saisir une commande du modèle suivant :

localectl set-locale LANG=en_GB.utf8

~]# localectl set-locale LANG=en_GB.utf81.2. Modifier l'agencement du clavier

1.2.1. Afficher les paramètres actuels

localectl status

localectl statusExemple 1.4. Afficher les paramètres du clavier

localectl status

System Locale: LANG=en_US.utf8

VC Keymap: us

X11 Layout: us

~]$ localectl status

System Locale: LANG=en_US.utf8

VC Keymap: us

X11 Layout: us

1.2.2. Répertorier les agencements de clavier disponibles

localectl list-keymaps

localectl list-keymapsExemple 1.5. Rechercher un agencement de clavier particulier

grep peut être utilisée pour rechercher un nom d'agencement de clavier particulier dans la sortie de la commande précédente. De multiples agencements de clavier sont souvent compatibles avec vos paramètres régionaux actuels. Par exemple, pour trouver des agencements de clavier tchèques, veuillez saisir :

1.2.3. Définir l'agencement du clavier

root :

localectl set-keymap map

localectl set-keymap maplocalectl list-keymaps. À moins que l'option --no-convert ne soit passée, le paramètre sélectionné est également appliqué au mappage du clavier par défaut du système de fenêtres X11, après l'avoir converti au mappage de clavier X11 correspondant le mieux. Ceci s'applique à l'inverse, vous pouvez spécifier les deux agencements de clavier avec la commande suivante en tant qu'utilisateur root :

localectl set-x11-keymap map

localectl set-x11-keymap map--no-convert.

localectl --no-convert set-x11-keymap map

localectl --no-convert set-x11-keymap mapExemple 1.6. Définir l'agencement du clavier X11 séparément

root, veuillez saisir :

localectl --no-convert set-x11-keymap de

~]# localectl --no-convert set-x11-keymap delocalectl status

System Locale: LANG=de_DE.UTF-8

VC Keymap: us

X11 Layout: de

~]$ localectl status

System Locale: LANG=de_DE.UTF-8

VC Keymap: us

X11 Layout: de

localectl set-x11-keymap map model variant options

localectl set-x11-keymap map model variant optionskbd(4).

1.3. Ressources supplémentaires

Documentation installée

localectl(1) — la page du manuel de l'utilitaire de ligne de commandelocalectldocumente comment utiliser cet outil pour configurer les paramètres régionaux du système et la structure du clavier.loadkeys(1) — la page du manuel de la commandeloadkeysfournit des informations supplémentaires sur la manière d'utiliser cet outil pour modifier la structure du clavier dans une console virtuelle.

Voir aussi

- Le Chapitre 5, Obtention de privilèges documente comment obtenir des privilèges administratifs en utilisant les commandes

suetsudo. - Le Chapitre 9, Gérer les services avec systemd fournit des informations supplémentaires sur

systemdet documente comment utiliser la commandesystemctlpour gérer des services de système.

Chapitre 2. Configurer l'heure et la date

- Une horloge temps réel (« Real-Time Clock », ou RTC), communément appelée horloge matérielle, (habituellement un circuit intégré sur la carte système) est complètement indépendante de l'état actuel du système d'exploitation et fonctionne même lorsque l'ordinateur est éteint.

- Une horloge système, également appelée horloge logicielle, est habituellement maintenue par le noyau et sa valeur initiale est basée sur l'horloge temps réel. Une fois le système démarré et l'horloge système initialisée, celle-ci est entièrement indépendante de l'horloge temps réel.

timedatectl, qui est nouveau sur Red Hat Enterprise Linux 7 et fait partie de systemd ; la commande traditionnelle date ; et l'utilitaire hwclock pour accéder à l'horloge matérielle.

2.1. Utilisation de la commande timedatectl

systemd et permet de réviser et modifier la configuration de l'horloge système. Vous pouvez utiliser cet outil pour modifier l'heure et la date actuelle, pour définir le fuseau horaire, ou pour activer la synchronisation automatique de l'horloge système avec un serveur distant.

2.1.1. Afficher l'heure et la date actuelle

timedatectl sans aucune autre option de ligne de commande :

timedatectl

timedatectlNTP (« Network Time Protocol »), ainsi que des informations supplémentaires liées à DST.

Exemple 2.1. Afficher l'heure et la date actuelle

timedatectl sur un système qui n'utilise pas NTP pour synchroniser l'horloge système avec un serveur distant :

Important

chrony ou à ntpd ne seront pas notés immédiatement par timedatectl. S'il y a eu des changements de configuration ou de statut à ces outils, saisir la commande suivante :

systemctl restart systemd-timedated.services

~]# systemctl restart systemd-timedated.services2.1.2. Modifier l'heure actuelle

root:

timedatectl set-time HH:MM:SS

timedatectl set-time HH:MM:SSdate --set et hwclock --systohc.

NTP est activé. Voir Section 2.1.5, « Synchroniser l'horloge système avec un serveur à distance » pour désactiver le service de façon temporaire.

Exemple 2.2. Modifier l'heure actuelle

root :

timedatectl set-time 23:26:00

~]# timedatectl set-time 23:26:00timedatectl avec l'option set-local-rtc en tant qu'utilisateur root :

timedatectl set-local-rtc boolean

timedatectl set-local-rtc booleanyes (ou bien par y, true, t, ou 1). Pour configurer le système de manière à utiliser UTC, veuillez remplacer boolean par no (ou bien par, n, false, f, ou 0). L'option par défaut est no.

2.1.3. Modifier la date actuelle

root:

timedatectl set-time YYYY-MM-DD

timedatectl set-time YYYY-MM-DDExemple 2.3. Modifier la date actuelle

root :

timedatectl set-time '2013-06-02 23:26:00'

~]# timedatectl set-time '2013-06-02 23:26:00'2.1.4. Modifier le fuseau horaire

timedatectl list-timezones

timedatectl list-timezonesroot :

timedatectl set-timezone time_zone

timedatectl set-timezone time_zonetimedatectl list-timezones.

Exemple 2.4. Modifier le fuseau horaire

timedatectl avec l'option de ligne de commande list-timezones. Par exemple, pour répertorier tous les fuseaux horaires en Europe, veuillez saisir :

Europe/Prague, veuillez saisir ce qui suit en tant qu'utilisateur root :

timedatectl set-timezone Europe/Prague

~]# timedatectl set-timezone Europe/Prague2.1.5. Synchroniser l'horloge système avec un serveur à distance

timedatectl vous permet également d'activer la synchronisation automatique de votre horloge système avec un groupe de serveurs à distance en utilisant le protocole NTP. L'activation de NTP active chronyd ou ntpd, selon le service installé.

NTP peut être activé et désactivé par une commande sur le modèle suivant :

timedatectl set-ntp boolean

timedatectl set-ntp booleanNTP à distance, veuillez remplacer boolean par yes (option par défaut). Pour désactiver cette fonctionnalité, veuillez remplacer boolean par no.

Exemple 2.5. Synchroniser l'horloge système avec un serveur à distance

timedatectl set-ntp yes

~]# timedatectl set-ntp yesNTP n'est pas installé. Voir Section 15.3.1, « Installer Chrony » pour plus d'informations.

2.2. Utiliser la commande date

date est disponible sur tous les systèmes Linux et vous permet d'afficher et de configurer l'heure et la date actuelle. Celle-ci est fréquemment utilisée dans les scripts pour afficher des informations détaillées sur l'horloge système sous un format personnalisé.

timedatectl ».

2.2.1. Afficher l'heure et la date actuelle

date sans aucune autre option de ligne de commande :

date

datedate affiche l'heure local. Pour afficher l'heure UTC, veuillez exécuter la commande avec l'option de ligne de commande --utc ou -u :

date --utc

date --utc+"format" sur la ligne de commande :

date +"format"

date +"format"date(1) pour une liste complète de ces options.

| Séquence de contrôle | Description |

|---|---|

%H | Heures sous le format HH (par exemple, 17). |

%M | Minutes sous le format MM (par exemple, 30). |

%S | Secondes sous le format SS (par exemple, 24). |

%d | Jour du mois sous le format DD (par exemple, 16). |

%m | Mois sous le format MM (par exemple, 09). |

%Y | Année sous le format YYYY (par exemple, 2013). |

%Z | Abbréviation du fuseau horaire (par exemple, CEST). |

%F | Date complète sous le format YYYY-MM-DD (par exemple, 2013-09-16). Cette option correspond à %Y-%m-%d. |

%T | Heure complète sous le format HH:MM:SS (par exemple, 17:30:24). Cette option correspond à %H:%M:%S |

Exemple 2.6. Afficher l'heure et la date actuelle

date Mon Sep 16 17:30:24 CEST 2013

~]$ date

Mon Sep 16 17:30:24 CEST 2013date --utc Mon Sep 16 15:30:34 UTC 2013

~]$ date --utc

Mon Sep 16 15:30:34 UTC 2013date, veuillez saisir :

date +"%Y-%m-%d %H:%M" 2013-09-16 17:30

~]$ date +"%Y-%m-%d %H:%M"

2013-09-16 17:302.2.2. Modifier l'heure actuelle

date avec l'option --set ou -s en tant qu'utilisateur root :

date --set HH:MM:SS

date --set HH:MM:SSdate définit l'horloge système sur l'heure locale. Pour définir l'horloge système sur UTC, exécutez la commande avec l'option de ligne de commande --utc ou -u :

date --set HH:MM:SS --utc

date --set HH:MM:SS --utcExemple 2.7. Modifier l'heure actuelle

root :

date --set 23:26:00

~]# date --set 23:26:002.2.3. Modifier la date actuelle

date avec l'option --set ou -s en tant qu'utilisateur root :

date --set YYYY-MM-DD

date --set YYYY-MM-DDExemple 2.8. Modifier la date actuelle

root :

date --set 2013-06-02 23:26:00

~]# date --set 2013-06-02 23:26:002.3. Utilisation de la commande hwclock

hwclock est un utilitaire pour accéder à l'horloge matérielle, également appelée horloge RTC (« Real Time Clock »). L'horloge matérielle est indépendante du système d'exploitation utilisé et fonctionne même lorsque l'ordinateur est éteint. Cet utilitaire est utilisé pour afficher l'heure de l'horloge matérielle. hwclock offre aussi la possibilité de compenser pour la dérive systématique de l'horloge matérielle.

hwclock enregistre ses paramètres dans le fichier /etc/adjtime, qui est créé lors du premier changement effectué. Par exemple, lorsque l'heure est définie manuellement ou lorsque l'horloge matérielle est synchronisée avec l'heure système.

Note

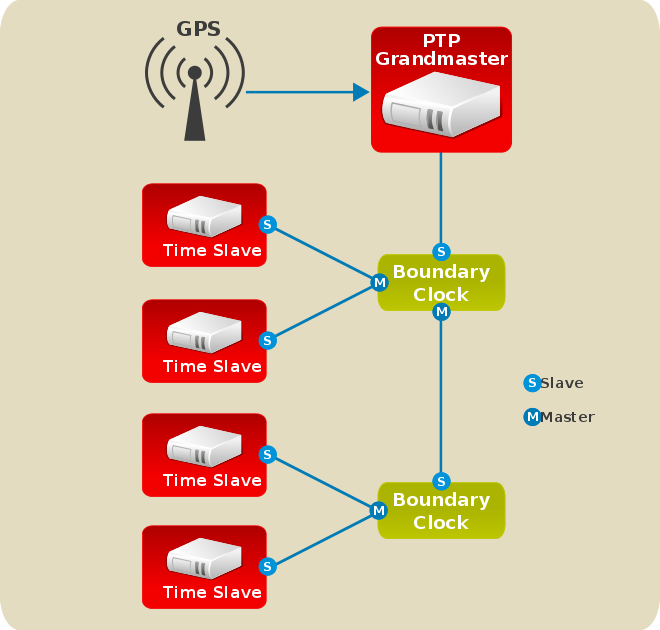

hwclock était exécutée automatiquement à chaque fermeture ou redémarrage du système, mais ceci n'est pas le cas sur Red Hat Enterprise Linux 7. Lorsque l'horloge système est synchronisée par le protocole NTP (« Network Time Protocol ») ou PTP (« Precision Time Protocol »), le noyau synchronise automatiquement l'horloge matérielle avec l'horloge système toutes les 11 minutes.

2.3.1. Afficher l'heure et la date actuelle

hwclock sans aucun option de ligne de commande en tant qu'utilisateur root retourne l'heure et la date locale sur la sortie standard.

hwclock

hwclock--utc ou --localtime avec la commande hwclock ne signifie pas que vous tentiez d'afficher l'heure de l'horloge matérielle en temps UTC ou en temps local. Ces options sont utilisées pour définir l'horloge matérielle de manière à conserver l'heure. L'heure est toujours affichée en heure locale. En outre, l'utilisation des commandes hwclock --utc ou hwclock --local ne modifie pas l'enregistrement dans le fichier /etc/adjtime. Cette commande peut être utile lorsque vous savez que le paramètre enregistré dans /etc/adjtime est incorrect mais que vous ne souhaitez pas modifier ce paramètre. D'autre part, vous pourriez recevoir des informations risquant de vous induire en erreur si vous utilisez une commande de la mauvaise manière. Veuillez consulter la page man de hwclock(8) pour obtenir davantage de détails.

Exemple 2.9. Afficher l'heure et la date actuelle

root :

hwclock Tue 15 Apr 2014 04:23:46 PM CEST -0.329272 seconds

~]# hwclock

Tue 15 Apr 2014 04:23:46 PM CEST -0.329272 seconds2.3.2. Paramétrer l'heure et la date

--set et --date dans vos spécifications :

hwclock --set --date "dd mmm yyyy HH:MM"

hwclock --set --date "dd mmm yyyy HH:MM"--utc ou --localtime, respectivement. Dans ce cas, UTC ou LOCAL est enregistré dans le fichier /etc/adjtime.

Exemple 2.10. Paramétrer l'horloge matérielle à une heure et date en particulier

root sous le format suivant :

hwclock --set --date "21 Oct 2014 21:17" --utc

~]# hwclock --set --date "21 Oct 2014 21:17" --utc2.3.3. Synchroniser l'heure et la date

- Vous pouvez définir l'horloge matérielle sur l'heure système actuelle à l'aide de cette commande :

hwclock --systohc

hwclock --systohcCopy to Clipboard Copied! Toggle word wrap Toggle overflow Remarquez que si vous utilisez NTP, l'horloge matérielle est automatiquement synchronisée à l'horloge système toutes les 11 minutes, et cette commande n'est utile que pendant le démarrage pour obtenir une heure système initiale raisonnable. - Vous pouvez également définir l'heure système à partir de l'horloge matérielle en utilisant la commande suivante :

hwclock --hctosys

hwclock --hctosysCopy to Clipboard Copied! Toggle word wrap Toggle overflow

--utc ou --localtime. De même qu'avec --set, UTC ou LOCAL est enregistré dans le fichier /etc/adjtime.

hwclock --systohc --utc est fonctionnellement similaire à timedatectl set-local-rtc false et la commande hwclock --systohc --local est une alternative à timedatectl set-local-rtc true.

Exemple 2.11. Synchroniser l'horloge matérielle avec l'heure système

root :

hwclock --systohc --localtime

~]# hwclock --systohc --localtime2.4. Ressources supplémentaires

Documentation installée

timedatectl(1) — la page du ma de l'utilitaire de ligne de commandetimedatectldocumente comment utiliser cet outil pour effectuer des requêtes et modifier l'horloge système et ses paramètres.date(1) — la page du man de la commandedatefournit une liste complète des options de ligne de commande prises en charge.hwclock(8) — la page du man de la commandehwclockfournit une liste complète des options de ligne de commande.

Voir aussi

- Chapitre 1, Paramètres régionaux et configuration du clavier documente comment configurer l'agencement du clavier.

- Chapitre 5, Obtention de privilèges documente comment obtenir des privilèges administratifs en utilisant les commandes

suetsudo. - Chapitre 9, Gérer les services avec systemd fournit davantage d'informations sur systemd et documente comment utiliser la commande

systemctlpour gérer les services du système.

Chapitre 3. Gérer les utilisateurs et les groupes

3.1. Introduction aux utilisateurs et aux groupes

root, et les permissions d'accès quant à elles peuvent être modifiées aussi bien par l'utilisateur root, que par le propriétaire du fichier.

ID d'utilisateurs et de groupes réservés

cat /usr/share/doc/setup*/uidgid

cat /usr/share/doc/setup*/uidgidUID_MIN et GID_MIN dans le fichier /etc/login.defs :

[file contents truncated] UID_MIN 5000[file contents truncated] GID_MIN 5000[file contents truncated]

[file contents truncated]

UID_MIN 5000[file contents truncated]

GID_MIN 5000[file contents truncated]Note

UID_MIN et GID_MIN, les UID démarreront toujours par la valeur par défaut de 1000.

3.1.1. Groupes privés d'utilisateurs

/etc/bashrc. Habituellement sur les système basés UNIX, l'umask a pour valeur 022, ce qui permet uniquement à l'utilisateur ayant créé le fichier ou le répertoire d'effectuer des modifications. Sous ce schéma, tous les autres utilisateurs, y compris les membres du groupe du créateur, ne sont pas autorisés à effectuer des modifications. Cependant, sous le schéma UPG, cette « protection de groupe » n'est pas nécessaire puisque chaque utilisateur possède son propre groupe privé.

/etc/group.

3.1.2. Mots de passe cachés (« Shadow Passwords »)

- Les mots de passe cachés améliorent la sécurité du système en déplaçant les hachages de mots de passe chiffrés depuis le fichier lisible

/etc/passwdsur le fichier/etc/shadow, qui est uniquement lisible par l'utilisateurroot. - Les mots de passe cachés stockent des informations sur l'ancienneté du mot de passe.

- Les mots de passe cachés permettent d'appliquer les politiques de sécurité définies dans le fichier

/etc/login.defs.

/etc/shadow, certains utilitaires et certaines commandes ne fonctionneront pas si les mots de passe cachés ne sont pas activés :

- Utilitaire

chagepour définir les paramètres d'ancienneté de mot de passe. Pour obtenir des détails, veuillez consulter la section Sécurité du mot de passe dans le Guide de sécurité Red Hat Enterprise Linux 7. - Utilitaire

gpasswdpour administrer le fichier/etc/group. - Commande

usermodavec l'option-e, --expiredateou-f, --inactive. - La commande

useraddavec l'option-e, --expiredateou-f, --inactive.

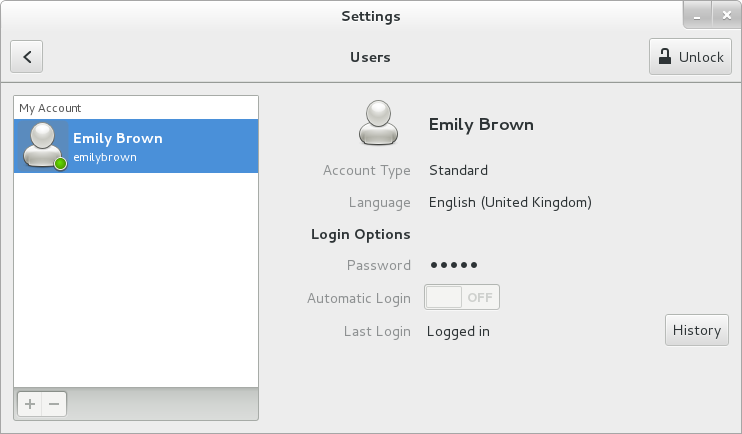

3.2. Gestion des utilisateurs dans un environnement graphique

3.2.1. Utiliser l'outil des paramètres d'utilisateurs « Users Settings Tool »

Users puis appuyez sur Entrée. L'outil des paramètres Users s'affiche. La touche Super apparaît sous une variété de formes, selon le clavier et matériel, mais le plus souvent, il s'agit de la touche Windows ou Commande, et elle se trouve habituellement à gauche de la barre d'espace. Alternativement, vous pouvez ouvrir l'utilitaire Users à partir du menu après avoir cliqué sur votre nom d'utilisateur dans le coin supérieur droit de l'écran.

root. Pour ajouter et supprimer des utilisateurs, veuillez sélectionner les boutons et respectivement. Pour ajouter un utilisateur au groupe administratif wheel, veuillez changer le de Standard à Administrateur. Pour modifier le paramètre de langue d'un utilisateur, veuillez sélectionner la langue et un menu déroulant apparaîtra.

Figure 3.1. Outil des paramètres d'utilisateurs « Users Settings Tool »

Figure 3.2. Menu Password

3.3. Utiliser des outils de ligne de commande

| Utilitaires | Description |

|---|---|

id | Affiche les ID d'utilisateur et de groupe. |

useradd, usermod, userdel | Utilitaires standard pour ajouter, modifier, et supprimer des comptes utilisateur. |

groupadd, groupmod, groupdel | Utilitaires standard pour ajouter, modifier, et supprimer des groupes. |

gpasswd | Utilitaire utilisé surtout pour modifier le mot de passe du groupe dans le fichier /etc/gshadow utilisé par la commande newgrp. |

pwck, grpck | Utilitaires pouvant être utilisés pour la vérification du mot de passe, du groupe et des fichiers cachés associés. |

pwconv, pwunconv | Utilitaires pouvant être utilisés pour la conversion de mots de passe en mots de passe cachés, ou au contraire de mots de passe cachés en mots de passe standard. |

grpconv, grpunconv | De manière similaire à ce qui précède, ces utilitaires peuvent être utilisés pour la conversion d'informations cachées pour les comptes de groupe. |

3.3.1. Ajout d'un nouvel utilisateur

root :

useradd [options] username

useradd [options] usernameuseradd crée un compte utilisateur verrouillé. Pour déverrouiller le compte, veuillez exécuter la commande suivante en tant qu'utilisateur root pour assigner un mot de passe :

passwd username

passwd username| Option | Description |

|---|---|

-c 'comment' | comment peut être remplacé par n'importe quelle chaîne. Cette option est généralement utilisée pour spécifier le nom complet d'un utilisateur. |

-d home_directory | Répertoire personnel à utiliser à la place de /home/username/. |

-e date | Date à laquelle le compte sera désactivé sous le format YYYY-MM-DD. |

-f days | Nombre de jours après l'expiration du mot de passe avant que le compte soit désactivé. Si 0 est spécifié, le compte est désactivé immédiatement après l'expiration du mot de passe. Si -1 est spécifié, le compte n'est pas désactivé après l'expiration du mot de passe. |

-g group_name | Nom de groupe ou numéro de groupe du groupe (principal) par défaut de l'utilisateur. Le groupe doit exister avant d'être spécifié ici. |

-G group_list | Liste des noms ou numéros de groupes supplémentaires (autres que ceux par défaut), séparés par des virgules, dont l'utilisateur est membre. Les groupes doivent exister avant d'être spécifiés ici. |

-m | Créer le répertoire personnel s'il n'existe pas. |

-M | Ne pas créer de répertoire personnel. |

-f | Ne pas créer de groupe privé d'utilisateurs pour l'utilisateur. |

-p password | Mot de passe chiffré avec crypt. |

-r | Entraîne la création d'un compte système avec un ID utilisateur (UID) inférieur à 1000 et sans répertoire personnel. |

-s | Shell de connexion de l'utilisateur, qui est par défaut /bin/bash. |

-u uid | ID utilisateur de l'utilisateur, qui doit être unique et supérieur à 999. |

usermod sont essentiellement les mêmes. Remarquez que si vous souhaitez ajouter un utilisateur à un autre groupe supplémentaire, vous devrez utiliser l'option -a, --append avec l'option -G. Sinon, la liste des groupes supplémentaires de l'utilisateur sera remplacée par ceux spécifiés par la commande usermod -G.

Important

/etc/login.defs.

Explication du processus

useradd juan est exécutée sur un système sur lequel les mots de passe cachés sont activés :

- Une nouvelle ligne pour

juanest créée dans/etc/passwd:juan:x:1001:1001::/home/juan:/bin/bash

juan:x:1001:1001::/home/juan:/bin/bashCopy to Clipboard Copied! Toggle word wrap Toggle overflow La ligne possède les caractéristiques suivantes :- Celle-ci commence par le nom d'utilisateur

juan. - Un

xse trouve dans le champ du mot de passe, indiquant que le système utilise des mots de passe cachés. - Un UID supérieur à 999 est créé. Dans Red Hat Enterprise Linux 7, les UID inférieurs à 1000 sont réservés à l'utilisation système et ne doivent pas être assignés aux utilisateurs.

- Un GID supérieur à 999 est créé. Dans Red Hat Enterprise Linux 7, les GID inférieurs à 1000 sont réservés à l'utilisation système et ne doivent pas être assignés aux utilisateurs.

- Les informations optionnelles GECOS sont laissées vides. Le champ GECOS peut être utilisé pour fournir des informations supplémentaires sur l'utilisateur, comme son nom complet ou son numéro de téléphone.

- Le répertoire personnel de

juanest défini sur/home/juan/. - Le shell par défaut est défini sur

/bin/bash.

- Une nouvelle ligne pour

juanest créée dans/etc/shadow:juan:!!:14798:0:99999:7:::

juan:!!:14798:0:99999:7:::Copy to Clipboard Copied! Toggle word wrap Toggle overflow La ligne possède les caractéristiques suivantes :- Celle-ci commence par le nom d'utilisateur

juan. - Deux points d'exclamation (

!!) apparaissent dans le champ du mot de passe du fichier/etc/shadow, qui verrouille le compte.Note

Si un mot de passe chiffré est saisi en utilisant l'indicateur-p, il sera placé dans le fichier/etc/shadowsur la nouvelle ligne pour l'utilisateur. - Le mot de passe est paramétré de manière à ne jamais expirer.

- Une nouvelle ligne pour un groupe nommé

juanest créée dans/etc/group:juan:x:1001:

juan:x:1001:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Un groupe avec le même nom qu'un utilisateur est appelé un groupe privé d'utilisateurs. Pour obtenir davantage d'informations sur les groupes privés d'utilisateurs, veuillez consulter la section Section 3.1.1, « Groupes privés d'utilisateurs ».La ligne créée dans/etc/grouppossède les caractéristiques suivantes :- Celle-ci commence par le nom de groupe

juan. - Un

xapparaît dans le champ du mot de passe, indiquant que le système utilise des mots de passe de groupe cachés. - Le GID correspond à celui qui est répertorié pour le groupe principal de

juandans/etc/passwd.

- Une nouvelle ligne pour un groupe nommé

juanest créée dans/etc/gshadow:juan:!::

juan:!::Copy to Clipboard Copied! Toggle word wrap Toggle overflow La ligne possède les caractéristiques suivantes :- Celle-ci commence par le nom de groupe

juan. - Un point d'exclamation (

!) apparaît dans le champ du mot de passe du fichier/etc/gshadow, qui verrouille le groupe. - Tous les autres champs sont vierges.

- Un répertoire pour l'utilisateur

juanest créé dans le répertoire/home:ls -ld /home/juan drwx------. 4 juan juan 4096 Mar 3 18:23 /home/juan

~]# ls -ld /home/juan drwx------. 4 juan juan 4096 Mar 3 18:23 /home/juanCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ce répertoire appartient à l'utilisateurjuanet au groupejuan. Il possède les privilèges read (lecture), write (écriture), et execute (exécution) uniquement pour l'utilisateurjuan. Toutes les autres permissions sont refusées. - Les fichiers dans le répertoire

/etc/skel/(qui contient les paramètres par défaut de l'utilisateur) sont copiés dans le nouveau répertoire/home/juan/:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

juan existe sur le système. Pour l'activer, l'administrateur doit assigner un mot de passe au compte en utilisant la commande passwd et optionnellement, paramétrer des directives concernant l'ancienneté du mot de passe (veuillez consulter la section Sécurité du mot de passe dans le Guide de sécurité Red Hat Enterprise Linux 7 pour obtenir des détails supplémentaires).

3.3.2. Ajout d'un nouveau groupe

root :

groupadd [options] group_name

groupadd [options] group_name| Option | Description |

|---|---|

-f, --force | Lorsqu'utilisé avec -g gid et que gid existe déjà, groupadd choisira un nouveau gid unique pour le groupe. |

-g gid | ID de groupe du groupe, qui doit être unique et supérieur à 999. |

-K, --key key=value | Remplace les valeurs par défaut de /etc/login.defs. |

-o, --non-unique | Permet la création de groupes avec un GID dupliqué. |

-p, --password password | Utilise ce mot de passe chiffré pour le nouveau groupe. |

-r | Entraîne la création d'un groupe système avec un GID inférieur à 1000. |

3.3.3. Création de répertoire de groupes

/opt/myproject/. Il est fait confiance à certaines personnes pour modifier le contenu de ce répertoire, mais pas à tout le monde.

- En tant qu'utilisateur

root, veuillez créer le répertoire/opt/myproject/en saisissant ce qui suit dans l'invite de shell :mkdir /opt/myproject

mkdir /opt/myprojectCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Ajoutez le groupe

myprojectau système :groupadd myproject

groupadd myprojectCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Associez le contenu du répertoire

/opt/myproject/au groupemyproject:chown root:myproject /opt/myproject

chown root:myproject /opt/myprojectCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Autorisez les utilisateurs du groupe à créer des fichiers dans le répertoire et paramétrez le setgid :

chmod 2775 /opt/myproject

chmod 2775 /opt/myprojectCopy to Clipboard Copied! Toggle word wrap Toggle overflow À ce moment, tous les membres du groupemyprojectpeuvent créer et modifier des fichiers dans le répertoire/opt/myproject/sans que l'administrateur ne soit obligé de modifier les permissions de fichier à chaque fois qu'un utilisateur écrit un nouveau fichier. Pour vérifier si les permissions ont été paramétrées correctement, veuillez exécuter la commande suivante :ls -ld /opt/myproject drwxrwsr-x. 3 root myproject 4096 Mar 3 18:31 /opt/myproject

~]# ls -ld /opt/myproject drwxrwsr-x. 3 root myproject 4096 Mar 3 18:31 /opt/myprojectCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Ajoutez les utilisateurs au groupe

myproject:usermod -aG myproject username

usermod -aG myproject usernameCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4. Ressources supplémentaires

Documentation installée

useradd(8) — la page du manuel de la commandeuseradddocumente comment l'utiliser pour créer de nouveaux utilisateurs.userdel(8) — la page du manuel de la commandeuserdeldocumente comment l'utiliser pour supprimer des utilisateurs.usermod(8) — la page du manuel de la commandeusermoddocumente comment l'utiliser pour modifier les utilisateurs.groupadd(8) — la page du manuel de la commandegroupadddocumente comment l'utiliser pour créer de nouveaux groupes.groupdel(8) — la page du manuel de la commandegroupdeldocumente comment l'utiliser pour supprimer des groupes.groupmod(8) — la page du manuel de la commandegroupmoddocumente comment l'utiliser pour modifier les appartenances aux groupes.gpasswd(1) — la page du manuel de la commandegpasswddocumente comment gérer le fichier/etc/group.grpck(8) — la page du manuel de la commandegrpckdocumente comment l'utiliser pour vérifier l'intégrité du fichier/etc/group.pwck(8) — la page du manuel de la commandepwckdocumente comment l'utiliser pour vérifier l'intégrité des fichiers/etc/passwdet/etc/shadow.pwconv(8) — la page du manuel des commandespwconv,pwunconv,grpconv, etgrpunconvdocumentent comment convertir des informations cachées pour des mots de passe et des groupes.id(1) — la page du manuel de la commandeiddocumente comment afficher les ID d'utilisateur et de groupe.

group(5) — la page du manuel du fichier/etc/groupdocumente comment utiliser ce fichier pour définir les groupes de système.passwd(5) — la page du manuel du fichier/etc/passwddocumente comment utiliser ce fichier pour définir les informations d'utilisateur.shadow(5) — la page du manuel du fichier/etc/shadowdocumente comment utiliser ce fichier pour définir les informations d'expiration des mots de passe et des comptes sur ce système.

Documentation en ligne

- Guide de sécurité Red Hat Enterprise Linux 7 — Le Guide de sécurité de Red Hat Enterprise Linux 7 fournit des informations supplémentaires sur la manière d'assurer le sécurité du mot de passe et de sécuriser la station de travail en activant l'ancienneté des mots de passe et le verrouillage des comptes utilisateur.

Voir aussi

- Le Chapitre 5, Obtention de privilèges documente comment obtenir des privilèges administratifs en utilisant les commandes

suetsudo.

Chapitre 4. Listes des contrôle d'accès (ACL)

acl et la prise en charge dans le noyau sont requis pour implémenter les ACL. Ce paquet contient les utilitaires nécessaires pour l'ajout, la modification, la suppression et la récupération d'informations sur les ACL.

cp et mv copient ou déplacent toutes les ACL associées à des fichiers et répertoires.

4.1. Monter des systèmes de fichiers

mount -t ext3 -o acl device-name partition

mount -t ext3 -o acl /dev/VolGroup00/LogVol02 /work

/etc/fstab, l'entrée de la partition peut inclure l'option acl :

LABEL=/work /work ext3 acl 1 2

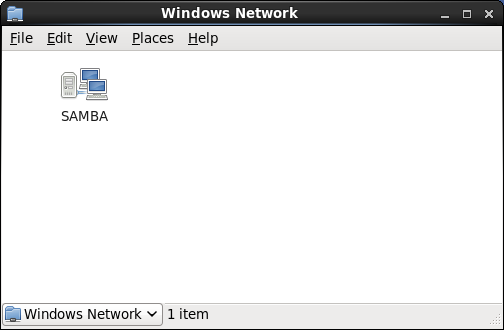

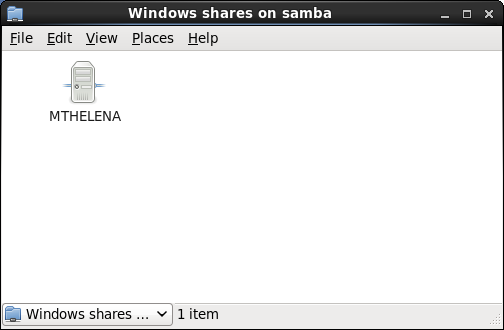

LABEL=/work /work ext3 acl 1 2--with-acl-support. Aucun indicateur particulier n'est requis lors de l'accession ou du montage d'un partage Samba.

4.1.1. NFS

no_acl dans le fichier /etc/exports. Pour désactiver les ACL d'un partage NFS quand vous la montez sur un client, montez-la avec l'option no_acl via la ligne de commandes ou par le fichier /etc/fstab

4.2. Définir les ACL d'accès

- Par utilisateur

- Par groupe

- Via le masque des droits en vigueur

- Pour les utilisateur ne se trouvant pas dans le groupe d'utilisateurs du fichier

setfacl définit les ACL pour les fichiers et répertoires. Veuillez utiliser l'option -m pour ajouter ou modifier l'ACL d'un fichier ou répertoire :

setfacl -m rules files

# setfacl -m rules filesu:uid:perms- Définit l'ACL d'accès d'un utilisateur. Le nom d'utilisateur, ou UID, peut être spécifié. L'utilisateur peut être tout utilisateur valide sur le système.

g:gid:perms- Définit l'ACL d'accès d'un groupe. Le nom du groupe, ou GID, peut être spécifié. Le groupe peut être tout groupe valide sur le système.

m:perms- Définit le masque des permissions. Le masque est l'union de toutes les permissions du groupe propriétaire et des toutes les entrées d'utilisateur et de groupe.

o:perms- Définit l'ACL d'accès du fichier pour les utilisateurs ne faisant pas partie du groupe.

r, w et x pour lecture, écriture, et exécution.

setfacl est utilisée, les règles supplémentaires sont ajoutées à l'ACL existante ou la règle existante sera modifiée.

Exemple 4.1. Donner des permissions de lecture et écriture

setfacl -m u:andrius:rw /project/somefile

# setfacl -m u:andrius:rw /project/somefile-x et ne spécifier aucune permission :

setfacl -x rules files

# setfacl -x rules filesExemple 4.2. Supprimer toutes les permissions

setfacl -x u:500 /project/somefile

# setfacl -x u:500 /project/somefile4.3. Définit les ACL par défaut

d: avant la règle et spécifiez un répertoire à la place d'un nom de fichier.

Exemple 4.3. Définir les ACL par défaut

/share/ afin de pouvoir effectuer des lectures et exécutions pour les utilisateurs ne se trouvant pas dans le groupe d'utilisateurs (une ACL d'accès pour un fichier individuel peut la remplacer) :

setfacl -m d:o:rx /share

# setfacl -m d:o:rx /share4.4. Récupérer des ACL

getfacl. Dans l'exemple ci-dessous, getfacl est utilisé pour déterminer les ACL existantes pour un fichier.

Exemple 4.4. Récupérer des ACL

getfacl home/john/picture.png

# getfacl home/john/picture.pnggetfacl home/sales/ affichera une sortie similaire à la suivante :

4.5. Archiver des systèmes de fichiers avec des ACL

dump préserve désormais les ACL pendant les opérations de sauvegarde. Lors de l'archivage d'un fichier ou d'un système de fichiers avec tar, utilisez l'option --acls pour préserver les ACL. De manière similaire, lors de l'utilisation de cp pour copier des fichiers avec des ACL, veuillez inclure l'option --preserve=mode afin de vous assurer que les ACL soient également copiées. En outre, l'option -a (équivalente à -dR --preserve=all) de cp préserve également les ACL lors des opérations de sauvegarde ainsi que d'autres informations, commes les horodatages, les contextes SELinux, etc. Pour obtenir davantage d'informations sur dump, tar, ou cp, veuillez consulter les pages man respectives.

star est similaire à l'utilitaire tar car il peut être utilisé pour générer des archives de fichiers ; cependant, certaines de ses options sont différentes. Veuillez consulter le Tableau 4.1, « Options de ligne de commande pour star » pour obtenir une liste des options communément utilisées. Pour toutes les options disponibles, veuillez consulter man star. Le paquet star est requis pour faire usage de cet utilitaire.

| Option | Description |

|---|---|

-c | Crée un fichier archive. |

-n | Ne pas extraire les fichiers. À utiliser en conjonction avec -x pour afficher le résultat provoqué par l'extraction de fichiers. |

-r | Remplace les fichiers dans l'archive. Les fichiers sont écrits à la fin du fichier archive, remplaçant tout fichier ayant le même chemin et le même nom de fichier. |

-t | Affiche le contenu du fichier archive. |

-u | Met à jour le fichier archive. Les fichiers sont écrits à la fin de l'archive si ceux-ci n'existent pas dans l'archive, ou si les fichiers sont plus récents que les fichiers de même nom dans l'archive. Cette option fonctionne uniquement si l'archive est un fichier ou une bande non-bloquée pouvant être inversé. |

-x | Extrait les fichiers de l'archive. Si utilisé avec -U et qu'un fichier dans l'archive est plus ancien que le fichier correspondant sur le système de fichers, le fichier ne sera pas extrait. |

-help | Affiche les options les plus importantes. |

-xhelp | Affiche les options les moins importantes. |

-/ | Ne pas supprimer les barres obliques des noms de fichiers lors de l'extraction de fichiers d'une archive. Par défaut, celles-ci sont supprimées lorsque les fichiers sont extraits. |

-acl | Pendant la création ou l'extraction, archive ou restaure toute ACL associée aux fichiers et répertoires. |

4.6. Compatibilité avec d'anciens systèmes

ext_attr. Cet attribut peut être affiché à l'aide de la commande suivante :

tune2fs -l filesystem-device

# tune2fs -l filesystem-deviceext_attr peut être monté avec d'anciens noyaux, mais ces noyaux n'appliqueront aucune ACL définie.

e2fsck incluses dans la version 1.22 et dans les versions supérieures du paquet e2fsprogs (y compris les versions dans Red Hat Enterprise Linux 2.1 et 4) peuvent vérifier un système de fichiers avec l'attribut ext_attr. Les versions plus anciennes refuseront de le vérifier.

4.7. Références des ACL

man acl— Description des ACLman getfacl— Traite de la manière d'obtenir des listes de contrôle d'accèsman setfacl— Explique comment définir des listes de contrôle d'accès aux fichiersman star— Explique l'utilitairestaret ses nombreuses options

Chapitre 5. Obtention de privilèges

root est potentiellement dangereux et peut causer des dommages qui se répandent sur le système et sur les données. Ce chapitre couvre les manières d'obtenir des privilèges administratifs en utilisant des programmes setuid tels que su et sudo. Ces programmes autorisent des utilisateurs spécifiques à effectuer des tâches qui seraient normalement uniquement disponibles à l'utilisateur root tout en conservant un niveau de contrôle et de sécurité du système élevés.

5.1. La commande su

su, il lui est demandé le mot de passe de l'utilisateur root. Une invite de shell root s'ouvrira après l'authentification.

su, l'utilisateur devient l'utilisateur root et possède un accès administratif absolu sur le système. Veuillez remarquer que cet accès reste sujet aux restrictions imposées par SELinux, si activé. En outre, une fois qu'un utilisateur est connecté en tant qu'utilisateur root, il est lui est possible d'utiliser la commande su pour modifier tout autre utilisateur sur le système sans avoir à saisir de mot de passe.

root :

usermod -a -G wheel username

~]# usermod -a -G wheel usernamewheel.

- Veuillez appuyer sur la touche Super pour accéder à « Vue d'ensembles des activités », saisissez

Utilisateurspuis appuyez sur Entrée. L'outil des paramètres Utilisateurs s'affiche. La touche Super apparaît sous une variété de formes, selon le clavier et autre matériel, mais le plus souvent, il s'agit de la touche Windows ou Commande, et elle se trouve habituellement à gauche de la Barre d'espace. - Pour autoriser les modifications, veuillez cliquer sur le bouton , puis saisissez un mot de passe d'administrateur valide.

- Veuillez cliquer sur l'icône dans la colonne de gauche pour afficher les propriétés de l'utilisateur dans le volet du côté droit.

- Modifiez le de

StandardàAdministrateur. Cela aura pour effet d'ajouter l'utilisateur au groupewheel.

wheel, il est recommandé d'autoriser ces utilisateurs spécifiques uniquement à utiliser la commande su. Pour faire cela, veuillez modifier le fichier de configuration Pluggable Authentication Module (PAM) de su, /etc/pam.d/su. Ouvrez ce fichier dans un éditeur de texte et enlevez la ligne suivante du commentaire en supprimant le caractère # :

#auth required pam_wheel.so use_uid

#auth required pam_wheel.so use_uidwheel peuvent basculer sur un autre utilisateur en utilisant la commande su.

Note

root fait partie du groupe wheel par défaut.

5.2. La commande sudo

sudo offre une autre approche pour donner un accès administratif aux utilisateurs. Lorsque des utilisateurs de confiance ajoutent sudo avant une commande administrative, il leur est demandé leur propre mot de passe. Puis, lorsqu'ils ont été authentifié et en supposant que la commande soit autorisée, la commande administrative est exécutée comme s'ils étaient un utilisateur root.

sudo est comme suit :

sudo command

sudo commandroot, telle que mount.

sudo offre un haut niveau de flexibilité. Par exemple, seuls les utilisateurs répertoriés dans le fichier de configuration /etc/sudoers sont autorisés à utiliser la commande sudo et la commande est exécutée dans le shell de l'utilisateur, et non dans un shell root. Cela signifie que le shell root peut être complètement désactivé, comme indiqué dans le Guide de sécurité Red Hat Enterprise Linux 7.

sudo est journalisée sur le fichier /var/log/messages et la commande passée avec le nom d'utilisateur de son émetteur est journalisée sur le fichier /var/log/secure. Si davantage de détails sont requis, veuillez utiliser le module pam_tty_audit pour activer les audits TTY pour des utilisateurs spécifiques en ajoutant la ligne suivante à votre fichier /etc/pam.d/system-auth :

session required pam_tty_audit.so disable=pattern enable=pattern

session required pam_tty_audit.so disable=pattern enable=patternroot et les désactivera pour tous les autres utilisateurs :

session required pam_tty_audit.so disable=* enable=root

session required pam_tty_audit.so disable=* enable=rootImportant

pam_tty_audit pour les audits TTY n'enregistre que les entrées TTY. Cela signifie que, lorsque l'utilisateur audité se connecte, pam_tty_audit enregistre les saisies de touches précises de l'utilisateur dans le fichier /var/log/audit/audit.log. Pour plus d'informations, voir la page man pam_tty_audit(8).

sudo est qu'un administrateur peut autoriser différents utilisateurs à accéder à des commandes spécifiques en fonction de leurs besoins.

sudo, /etc/sudoers, doivent utiliser la commande visudo.

visudo et ajoutez une ligne similaire à la suivante dans la section de spécification des privilèges utilisateur :

juan ALL=(ALL) ALL

juan ALL=(ALL) ALLjuan peut utiliser sudo à partir de n'importe quel hôte et peut exécuter n'importe quelle commande.

sudo :

%users localhost=/usr/sbin/shutdown -h now

%users localhost=/usr/sbin/shutdown -h nowusers peut exécuter la commande /sbin/shutdown -h now tant que c'est à partir de la console.

sudoers offre une liste détaillée des options pour ce fichier.

Important

sudo. Vous pouvez les éviter en modifier le fichier de configuration /etc/sudoers en utilisant visudo, comme indiqué ci-dessus. Laisser le ficher /etc/sudoers dans son état par défaut donnera à tout utilisateur du groupe wheel un accès root illimité.

- Par défaut,

sudostocke le mot de passe de l'utilisateur sudo pour une période de cinq minutes. Toute utilisation de la commande pendant cette période ne demandera pas à l'utilisateur de saisir à nouveau le mot de passe. Ceci peut être exploité par une personne malveillante si l'utilisateur laisse son poste de travail connecté, sans surveillance et déverrouillé. Ce comportement peut être modifié en ajoutant la ligne suivante au fichier/etc/sudoers:Defaults timestamp_timeout=value

Defaults timestamp_timeout=valueCopy to Clipboard Copied! Toggle word wrap Toggle overflow où value est la longueur souhaitée du délai en minutes. Définir value sur 0 amènesudoà réclamer un mot de passe à chaque fois. - Si le compte sudo d'utilisateur est compromis, une personne malveillante peut utiliser

sudopour ouvrir un nouveau shell avec des privilèges administratifs :sudo /bin/bash

sudo /bin/bashCopy to Clipboard Copied! Toggle word wrap Toggle overflow L'ouverture d'un nouveau shell en tant qu'utilisateurrootde cette manière, ou d'une manière similaire, peut offrir un accès administratif à une personne malveillante sur une durée théoriquement illimitée, outrepassant ainsi la limite de la durée du délai spécifiée dans le fichier/etc/sudoerset il ne sera pas demandé à cette personne malveillante de ressaisir le mot de passesudotant que la session ouverte n'est pas fermée.

5.3. Ressources supplémentaires

Documentation installée

su(1) — la page man desuoffre des informations concernant les options dispionibles avec cette commande.sudo(8) — la page man desudoinclut une description détaillée de la commande et répertorie les options disponibles pour personnaliser son comportement.pam(8) — page du manuel décrivant l'utilisation des modules PAM manual (« Pluggable Authentication Modules ») pour Linux.

Documentation en ligne

- Guide de sécurité Red Hat Enterprise Linux 7 — le Guide de sécurité de Red Hat Enterprise Linux 7 traite de manière plus approfondie des problèmes de sécurité pertinents aux programmes setuid, ainsi que des techniques utilisées pour réduire ces risques.

Voir aussi

- Le Chapitre 3, Gérer les utilisateurs et les groupes documente comment gérer les groupes et utilisateurs système dans l'interface utilisateur graphique et sur la ligne de commande.

Partie II. Abonnement et support

Chapitre 6. Enregistrer le système et Gérer les abonnements

Note

6.1. Enregistrer le système et y ajouter des abonnnements

subscription-manager sont censées être exécutées en tant qu'utilisateur root.

- Exécutez la commande suivante pour enregistrer votre système. Votre nom d'utilisateur et votre mot de passe vous seront demandés. Remarquez que le nom d'utilisateur et le mot de passe sont les mêmes que vos identifiants de connexion pour le Portail Client Red Hat.

subscription-manager register

subscription-manager registerCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Déterminer l'ID du pool d'un abonnement dont vous avez besoin. Pour ce faire, tapez ce qui suit à une invite du shell pour afficher une liste de tous les abonnements qui sont disponibles pour votre système :

subscription-manager list --available

subscription-manager list --availableCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pour chaque abonnement disponible, cette commande affiche son nom, son identifiant unique, sa date d'expiration et autres détails liés à votre abonnement. Pour répertorier les abonnements de toutes les architectures, ajouter l'option--all. L'ID du pool est répertorié sur une ligne commençant parPool ID. - Attachez un abonnement qui convient au système en saisissant la commande suivante :

subscription-manager attach --pool=pool_id

subscription-manager attach --pool=pool_idCopy to Clipboard Copied! Toggle word wrap Toggle overflow Remplacez pool_id par l'ID de pool déterminé dans l'étape précédente.Pour vérifier la liste des abonnements actuellement attachés à votre système, exécutez, à tout moment :subscription-manager list --consumed

subscription-manager list --consumedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2. Gérer des référentiels de logiciels

/etc/yum.repos.d/. Pour vérifier cela, veuillez utiliser yum pour répertorier les référentiels activés :

yum repolist

yum repolistsubscription-manager repos --list

subscription-manager repos --listrhel-variant-rhscl-version-rpms rhel-variant-rhscl-version-debug-rpms rhel-variant-rhscl-version-source-rpms

rhel-variant-rhscl-version-rpms

rhel-variant-rhscl-version-debug-rpms

rhel-variant-rhscl-version-source-rpmsserver ou workstation), et version est la version du système Red Hat Enterprise Linux (6 ou 7), par exemple :

rhel-server-rhscl-7-eus-rpms rhel-server-rhscl-7-eus-source-rpms rhel-server-rhscl-7-eus-debug-rpms

rhel-server-rhscl-7-eus-rpms

rhel-server-rhscl-7-eus-source-rpms

rhel-server-rhscl-7-eus-debug-rpmssubscription-manager repos --enable repository

subscription-manager repos --enable repositorysubscription-manager repos --disable repository

subscription-manager repos --disable repository6.3. Supprimer des abonnements

- Déterminez le numéro de série de l'abonnement que vous souhaitez supprimer en répertoriant les informations sur les abonnements déjà attachés :

subscription-manager list --consumed

subscription-manager list --consumedCopy to Clipboard Copied! Toggle word wrap Toggle overflow Le numér de série est le numéro répertorié en tant que sériel («serial»). Par exemple,744993814251016831ci-dessous :Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Saisissez une commande comme suit pour supprimer l'abonnement sélectionné :

subscription-manager remove --serial=serial_number

subscription-manager remove --serial=serial_numberCopy to Clipboard Copied! Toggle word wrap Toggle overflow Remplacez serial_number par le numéro de série déterminé dans l'étape précédente.

subscription-manager remove --all

subscription-manager remove --all6.4. Ressources supplémentaires

Documentation installée

subscription-manager(8) — la page du manuel de Red Hat Subscription Management fournit une liste complète des options et commandes prises en charge.

Livres apparentés

- Collection de guides Red Hat Subscription Management — Ces guides contiennent des informations détaillées sur la manière d'utiliser Red Hat Subscription Management.

- Guide d'installation — veuillez consulter le chapitre Installation initiale pour obtenir des informations détaillées sur la manière de s'enregistrer pendant le processus d'installation initiale.

Voir également

- Le Chapitre 5, Obtention de privilèges documente la façon d'obtenir des privilèges administratifs en utilisant les commandes

suetsudo. - Le Chapitre 8, Yum fournit des informations sur l'utilisation du gestionnaire de paquets yum pour installer et mettre à jour des logiciels.

Chapitre 7. Accéder au support en utilisant l'outil « Red Hat Support Tool »

SSH ou à partir de n'importe quel terminal. Par exemple, il permet d'effectuer des recherches dans la base de connaissances Red Hat (« Red Hat Knowledgebase ») à partir de la ligne de commande, de copier les solutions directement sur la ligne de commande, de créer et de mettre à jour des dossiers de support, et d'envoyer des fichier à Red Hat pour les analyser.

7.1. Installer l'outil Red Hat Support Tool

root :

yum install redhat-support-tool

~]# yum install redhat-support-tool7.2. Enregistrer l'outil Red Hat Support Tool en utilisant la ligne de commande

- Quand nom d'utilisateur correspond au nom d'utilisateur du compte sur le Portail Client Red Hat.

redhat-support-tool config user nom d'utilisateur

~]# redhat-support-tool config user nom d'utilisateurCopy to Clipboard Copied! Toggle word wrap Toggle overflow redhat-support-tool config password Please enter the password for username:

~]# redhat-support-tool config password Please enter the password for username:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3. Utiliser Red Hat Support Tool en mode shell interactif

redhat-support-tool Welcome to the Red Hat Support Tool. Command (? for help):

~]$ redhat-support-tool

Welcome to the Red Hat Support Tool.

Command (? for help):root.

?. Le programme ou la sélection du menu peuvent être « quittés » en saisissant le caractère q ou e. Votre nom d'utilisateur et votre mot de passe du Portail Client Red Hat vous seront demandés lors de votre première recherche sur la base de connaissances ou des dossiers de support. Alternativement, définissez le nom d'utilisateur et le mot de passe de votre compte Portail Client Red Hat en utilisant le mode interactif, et optionnellement, enregistrez-le sur le fichier de configuration.

7.4. Configurer l'outil Red Hat Support Tool

config --help :

Procédure 7.1. Enregistrer l'outil Red Hat Support Tool en utilisant le mode interactif

- Lancez l'outil en saisissant la commande suivante :

redhat-support-tool

~]# redhat-support-toolCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Saisissez votre nom d'utilisateur du Portail Client Red Hat :Pour enregistrer votre nom d'utilisateur dans le fichier de configuration globale , veuillez ajouter l'option

Command (? for help): config user nom d'utilisateur

Command (? for help): config user nom d'utilisateurCopy to Clipboard Copied! Toggle word wrap Toggle overflow -g. - Saisissez votre mot de passe du Portail Client Red Hat :

Command (? for help): config password Please enter the password for username:

Command (? for help): config password Please enter the password for username:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4.1. Enregistrer les paramètres dans les fichiers de configuration

~/.redhat-support-tool/redhat-support-tool.conf. Si requis, il est recommandé d'enregistrer les mots de passe dans ce fichier car il est uniquement lisible par cet utilisateur particulier. Lorsque l'outil est lancé, il lira les valeurs du fichier de configuration globale /etc/redhat-support-tool.conf ainsi que celles du fichier de configuration local. Les valeurs et options stockées localement ont priorité sur les paramètres stockés globalement.

Avertissement

/etc/redhat-support-tool.conf car le mot de passe est uniquement chiffré base64 et peut facilement être déchiffré. En outre, le fichier est lisible par tous.

-g, --global comme suit :

Command (? for help): config setting -g value

Command (? for help): config setting -g valueNote

-g, --global, l'outil Red Hat Support Tool doit être exécuté en tant qu'utilisateur root car les utilisateurs normaux n'ont pas les permissions requises pour écrire sur /etc/redhat-support-tool.conf.

-u, --unset comme suit :

Command (? for help): config setting -u value

Command (? for help): config setting -u valueNote

-u, --unset, mais elles peuvent être effacées, et annulées de la définition, à partir de l'instance actuellement en cours d'utilisation de l'outil en utilisant l'option -g, --global simultanément avec l'option -u, --unset. Si exécuté en tant qu'utilisateur root, les valeurs et options peuvent être supprimées du fichier de configuration globale en utilisant -g, --global simultanément avec l'option -u, --unset.

7.5. Créer et mettre à jour des dossiers de support en utilisant le mode interactif

Procédure 7.2. Créer un nouveau dossier de support en utilisant le mode interactif

- Lancez l'outil en saisissant la commande suivante :

redhat-support-tool

~]# redhat-support-toolCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Saisissez la commande

opencase:Command (? for help): opencase

Command (? for help): opencaseCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Suivez les invites affichées sur l'écran pour sélectionner un produit, puis une version.

- Saisissez un récapitulatif du dossier.

- Saisissez une description du dossier, puis appuyez sur Ctrl+D sur une ligne vide lorsque vous aurez terminé.

- Sélectionnez une sévérité pour le dossier.

- Optionnellement, vous pouvez choisir si une solution au problème existe avant de créer un dossier de support.

- Confirmez que vous souhaitez tout de même créer le dossier de support.

Le dossier de support 0123456789 a été créé

Le dossier de support 0123456789 a été crééCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Optionnellement, vous pouvez choisir d'attacher un rapport SOS.

- Optionnellement, vous pouvez choisir d'attacher un fichier.

Procédure 7.3. Afficher et mettre à jour un dossier de support existant en utilisant le mode interactif

- Lancez l'outil en saisissant la commande suivante :

redhat-support-tool

~]# redhat-support-toolCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Saisissez la commande

getcase:Quand numéro de cas correspond au numéro du dossier que vous souhaitez afficher et mettre à jour.Command (? for help): getcase case-number

Command (? for help): getcase case-numberCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Suivez les invites à l'écran pour afficher le dossier, modifier ou ajouter des commentaires, et pour obtenir ou ajouter des pièces jointes.

Procédure 7.4. Modifier un dossier de support existant en utilisant le mode interactif

- Lancez l'outil en saisissant la commande suivante :

redhat-support-tool

~]# redhat-support-toolCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Saisissez la commande

modifycase:Quand numéro de cas correspond au numéro du dossier que vous souhaitez afficher et mettre à jour.Command (? for help): modifycase numéro de cas

Command (? for help): modifycase numéro de casCopy to Clipboard Copied! Toggle word wrap Toggle overflow - La liste de modification de sélection s'affiche :Suivez les invites affichées sur l'écran pour modifier une ou plusieurs des options.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Par exemple, pour modifier le statut, veuillez saisir

3:Selection: 3 1 Waiting on Customer 2 Waiting on Red Hat 3 Closed Please select a status (or 'q' to exit):

Selection: 3 1 Waiting on Customer 2 Waiting on Red Hat 3 Closed Please select a status (or 'q' to exit):Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.6. Afficher des dossiers de support sur la ligne de commande

redhat-support-tool getcase case-number

~]# redhat-support-tool getcase case-number7.7. Ressources supplémentaires

Partie III. Installer et gérer un logiciel

Chapitre 8. Yum

Important

Note

su ou sudo.

8.1. Recherche et Mise à jour des paquets

8.1.1. Vérifier les mises à jour

yum check-update

yum check-updateExemple 8.1. Exemple de sortie de la commande yum check-update :

yum check-update peut être similaire à la suivante :

dracut— nom du paquetx86_64— architecture du CPU pour laquelle le paquet a été créé,0.5.8— version du paquet mis à jour à installer,360.el7— version du paquet mis à jour,_2— version ajoutée dans le cadre de la mise à jour z-stream,rhel-7-server-rpms— référentiel dans lequel le paquet mis à jour se trouve.

yum.

8.1.2. Mise à jour de paquets

Mise à jour d'un paquet unique

root :

yum update package_name

yum update package_nameExemple 8.2. Mise à jour du paquet rpm

Loaded plugins: langpacks, product-id, subscription-manager— Yum vous informe toujours quels greffons yum sont installés et activés. Veuillez consulter la Section 8.6, « Greffons Yum » pour des informations générales sur les greffons yum, ou la Section 8.6.3, « Utiliser des greffons Yum » pour des descriptions de greffons particuliers.rpm.x86_64— il est possible de télécharger et d'installer un nouveau paquet rpm ainsi que ses dépendances. Une vérification de transaction est effectuée pour chacun de ces paquets.- Yum présente les informations de mise à jour et vous demande de confirmer la mise à jour ; yum est exécuté interactivement par défaut. Si vous savez déjà quelles transactions la commande

yumplanifie d'effectuer, vous pouvez utiliser l'option-ypour répondre automatiquement oui («yes») à toute question posée par yum (dans ce cas, l'exécution n'est pas interactive). Cependant, vous devriez toujours examiner les changements que yum planifie d'effectuer sur le système afin de pouvoir facilement résoudre tout problème qui se pose. Il est également possible de télécharger le paquet sans l'installer. Pour faire cela, veuillez sélectionner l'optionddans l'invite du téléchargement. Cela lance le téléchargement en arrière-plan du paquet sélectionné.Si une transaction échoue, vous pouvez afficher l'historique des transactions yum en utilisant la commandeyum historycomme décrit dans la Section 8.4, « Utiliser l'historique des transactions ».

Important

yum update ou yum install.

rpm -i kernel qui installe un nouveau noyau, au lieu de rpm -u kernel qui remplace le noyau actuel. Veuillez consulter la Section A.2.1, « Installation et mise à niveau des paquets » pour obtenir davantage d'informations sur l'installation et la mise à niveau de noyaux avec RPM.

root :

yum group update group_name

yum group update group_nameupgrade qui est égale à update avec une option de configuration obsoletes (veuillez consulter la Section 8.5.1, « Définir les options [main] »). Par défaut, obsoletes est activé dans /etc/yum.conf, ce qui rend ces deux commandes équivalentes.

Mettre à jour tous les paquets et leurs dépendances

yum update sans aucun argument :

yum update

yum updateMettre à jour des paquets liés à la sécurité

root :

yum update --security

yum update --securityroot :

yum update-minimal --security

yum update-minimal --security- le paquet kernel-3.10.0-1 est installé sur votre système ;

- le paquet kernel-3.10.0-2 est une mise à jour de sécurité ;

- la paquet kernel-3.10.0-3 est une mise à jour de correctif,

yum update-minimal --security mettra à jour le paquet à kernel-3.10.0-2, et yum update --security mettra à jour le paquet à kernel-3.10.0-3.

8.1.3. Préserver les changements au fichier de configuration

8.1.4. Mise à jour du système hors ligne avec ISO et Yum

yum update avec l'image ISO d'installation de Red Hat Enterprise Linux est un façon simple et rapide de mettre à niveau les systèmes à la dernière version mineure. Les étapes suivantes nous montrent le processus de mise à niveau :

- Créer un répertoire cible dans lequel monter votre image ISO. Le répertoire n'est pas créé automatiquement lors du montage, donc, il vous faudra le créer avant de procéder à l'étape suivante. En tant qu'utilisateur

root, saisissez :mkdir mount_dir

mkdir mount_dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow Remplacer mount_dir par un chemin menant au répertoire de montage. Normalement, les utilisateurs le créent en tant que sous-répertoire du répertoire/media. - Monter l'image ISO d'installation de Red Hat Enterprise Linux 7 dans le répertoire cible préalablement créé. En tant qu'utilisateur

root, saisir :mount -o loop iso_name mount_dir

mount -o loop iso_name mount_dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow Remplacez iso_name par le nom du chemin de votre image ISO et mount_dir par le nom du chemin du répertoire cible. Là, l'option-oloopest exigée pour pouvoir monter le fichier en tant que périphérique bloc. - Copier le fichier

media.repodu répertoire de montage/etc/yum.repos.d/. Notez que les fichiers de configuration de ce répertoire doivent posséder l'extension .repo pour pouvoir fonctionner correctement.cp mount_dir/media.repo /etc/yum.repos.d/new.repo

cp mount_dir/media.repo /etc/yum.repos.d/new.repoCopy to Clipboard Copied! Toggle word wrap Toggle overflow Cela créera un fichier de configuration pour le référentiel yum. Remplacer new.repo par le nom du fichier, comme par exemple rhel7.repo. - Modifiez le nouveau fichier de configuration de façon à ce qu'il puisse pointer vers l'ISO d'installation de Red Hat Enterprise Linux. Ajouter la ligne suivante au fichier

/etc/yum.repos.d/new.repo:baseurl=file:///mount_dir

baseurl=file:///mount_dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow Remplacez mount_dir par un chemin qui mène au point de montage. - Mettez à jour tous les référentiels yum, y compris

/etc/yum.repos.d/new.repocréé dans les étapes précédentes. En tant qu'utilisateurroot, saisissez :yum update

yum updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow Cela mettra à jour votre système à la version fournie par l'image ISO montée. - Après la mise à niveau, vous pourrez dé-monter l'image ISO. En tant qu'utilisateur

root, saisissez :umount mount_dir

umount mount_dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow avec mount_dir comme chemin qui mène à votre répertoire de montage. Aussi, vous pourrez supprimer le répertoire de montage créé dans la première étape. En tant qu'utilisateurroot, saisissez :rmdir mount_dir

rmdir mount_dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Si vous ne souhaitez pas utiliser le fichier de configuration déjà créé pour une autre installation ou mise à jour, vous pouvez le supprimer. En tant qu'utilisateur

root, saisissez :rm /etc/yum.repos.d/new.repo

rm /etc/yum.repos.d/new.repoCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Exemple 8.3. Mise à niveau de Red Hat Enterprise Linux 7.0 à 7.1

rhel-server-7.1-x86_64-dvd.iso, créer un répertoire cible de montage, comme /media/rhel7/. En tant qu'utilisateur root, allez dans le répertoire avec votre image ISO et saisissez :

mount -o loop rhel-server-7.1-x86_64-dvd.iso /media/rhel7/

~]# mount -o loop rhel-server-7.1-x86_64-dvd.iso /media/rhel7/media.repo à partir du répertoire de montage :

cp /media/rhel7/media.repo /etc/yum.repos.d/rhel7.repo

~]# cp /media/rhel7/media.repo /etc/yum.repos.d/rhel7.repo/etc/yum.repos.d/rhel7.repo copié dans l'étape précédente :

baseurl=file:///media/rhel7/

baseurl=file:///media/rhel7/rhel-server-7.1-x86_64-dvd.iso. En tant qu'utilisateur root, exécutez :

yum update

~]# yum updateumount /media/rhel7/

~]# umount /media/rhel7/rmdir /media/rhel7/

~]# rmdir /media/rhel7/rm /etc/yum.repos.d/rhel7.repo

~]# rm /etc/yum.repos.d/rhel7.repo8.2. Utiliser des paquets

8.2.1. Rechercher des paquets

yum search term…

yum search term…Exemple 8.4. Rechercher les paquets correspondants à une chaîne spécifique

yum search est utile pour rechercher des paquets dont vous ne connaissez pas le nom, mais dont vous connaissez un terme connexe. Remarquez que par défaut, yum search retourne les correspondances par nom de paquet et résumé, ce qui rend les recherches plus rapides. Veuillez utiliser la commande yum search all pour effectuer une recherche plus exhaustive mais également plus lente.

Filtrer les résultats

* (qui s'étend pour correspondre à tout sous-ensemble de caractères) et ? (qui s'étend pour correspondre à tout caractère unique).

yum, sinon le shell Bash les interprétera comme des expansions de nom de fichier, et pourrait potentiellement faire passer tous les fichiers du répertoire actuel correspondant aux expressions globales sur yum. Pour vous assurer que les expressions glob soient passées sur yum comme souhaité, veuillez utiliser l'une des méthodes suivantes :

- échappez les caractères génériques en les faisant précéder du caractère de la barre oblique inversée

- mettez l'expression glob entre guillemets simples ou entre guillemets doubles.

8.2.2. Répertorier les paquets

yum list all

yum list allyum list glob_expression…

yum list glob_expression…Exemple 8.5. Répertorier les paquets liés à ABRT

installed. La colonne la plus à droite dans la sortie répertorie le référentiel à partir duquel le paquet a été récupéré.

yum list installed glob_expression…

yum list installed glob_expression…Exemple 8.6. Répertorier tous les versions installées du paquet krb

yum list installed "krb?-*" Loaded plugins: langpacks, product-id, search-disabled-repos, subscription-manager Installed Packages krb5-libs.x86_64 1.13.2-10.el7 @rhel-7-server-rpms

~]$ yum list installed "krb?-*"

Loaded plugins: langpacks, product-id, search-disabled-repos, subscription-manager

Installed Packages

krb5-libs.x86_64 1.13.2-10.el7 @rhel-7-server-rpmsyum list available glob_expression…

yum list available glob_expression…Exemple 8.7. Répertorier les greffons gstreamer disponibles

Répertorier les référentiels

yum repolist

yum repolist-v. Avec cette option activée, les informations comprenant le nom du fichier, la taille générale, la date de la dernière mise à jour, et l'URL de base sont affichées pour chaque référentiel répertorié. Alternativement, vous pouvez utiliser la commande repoinfo qui produira la même sortie.

yum repolist -v

yum repolist -vyum repoinfo

yum repoinfo yum repolist all

yum repolist alldisabled en tant que premier argument, vous pouvez limiter la sortie de la commande aux référentiels désactivés. Pour des spécifications plus précises, vous pouvez passer l'ID ou le nom des référentiels ou des glob_expressions comme arguments. Remarquez que s'il y a une correspondance exacte entre l'ID ou le nom du référentiel et l'argument inséré, ce référentiel est répertorié, même s'il ne passe pas le filtre enabled ou disabled.

8.2.3. Afficher des informations sur le paquet

yum info package_name…

yum info package_name…Exemple 8.8. Afficher des informations sur le paquet abrt

yum info package_name est similaire à la commande rpm -q --info package_name, mais elle fournit des informations supplémentaires, comme le nom du référentiel yum dans lequel le paquet RPM était installé (consultez la ligne From repo: dans la sortie).

Utiliser yumdb

yumdb info package_name

yumdb info package_nameuser indique une installation par l'utilisateur, et dep indique une installation pour raison de dépendance).

Exemple 8.9. Exécuter une requête yumdb pour trouver des informations sur le paquet yum

yumdb, veuillez consulter la page man de yumdb(8).

8.2.4. Installation de paquets

root :

yum install package_name

yum install package_nameroot :

yum install package_name package_name…

yum install package_name package_name…yum install package_name.arch

yum install package_name.archExemple 8.10. Installer des paquets sur un système multilib

i686, veuillez saisir :

yum install sqlite.i686

~]# yum install sqlite.i686root, veuillez exécuter :

yum install glob_expression…

yum install glob_expression…Exemple 8.11. Installer tous les greffons audacieux

yum install audacious-plugins-\*

~]# yum install audacious-plugins-\*yum install. Si vous connaissez le nom du binaire que vous souhaitez installer, mais pas son nom de paquet, vous pouvez donner le nom du chemin à yum install. En tant qu'utilisateur root, veuillez saisir :

yum install /usr/sbin/named

yum install /usr/sbin/named/usr/sbin/named, s'il existe, et vous demande si vous souhaitez l'installer.

yum install ne requiert pas d'arguments strictement définis. Il peut traiter divers formats de noms de paquets et d'expressions glob, ce qui rend l'installation plus facile pour les utilisateurs. D'autre part, yum peut prendre longtemps à analyser l'entrée correctement, particulièrement si vous spécifiez un grand nombre de paquets. Pour optimiser la recherche de paquets, vous pouvez utiliser les commandes suivantes pour définir de manière explicite comment analyser les arguments :

yum install-n name

yum install-n nameyum install-na name.architecture

yum install-na name.architectureyum install-nevra name-epoch:version-release.architecture

yum install-nevra name-epoch:version-release.architectureinstall-n, yum interprète name comme étant le nom exact du paquet. La commande install-na indique à yum que l'argument suivant contient le nom du paquet et l'architecture divisés par le caractère « point ». Avec install-nevra, yum s'attendra à un argument sous la forme name-epoch:version-release.architecture. Similairement, vous pouvez utiliser yum remove-n, yum remove-na, et yum remove-nevra lorsque vous cherchez des paquets à supprimer.

Note

named, mais que vous ne savez pas dans quel répertoire bin/ ou sbin/ le fichier est installé, veuillez utiliser la commande yum provides avec une expression glob :

yum provides "*/file_name" est une astuce utile pour trouver le paquet ou les paquets qui contiennent le file_name.

Exemple 8.12. Processus d'installation

root :

y (oui) et N (non), vous pouvez également choisir d (télécharger uniquement) pour télécharger les paquets sans les installer directement. Si vous choisissez y, l'installation continuera avec les messages suivants jusqu'à ce qu'elle se termine.

yum localinstall path

yum localinstall path8.2.5. Télécharger des paquets

... Total size: 1.2 M Is this ok [y/d/N]: ...

...

Total size: 1.2 M

Is this ok [y/d/N]:

...

d option, yum downloads the packages without installing them immediately. You can install these packages later offline with the yum localinstall command or you can share them with a different device. Downloaded packages are saved in one of the subdirectories of the cache directory, by default /var/cache/yum/$basearch/$releasever/packages/. The downloading proceeds in background mode so that you can use yum for other operations in parallel.

8.2.6. Supprimer des paquets

root :

yum remove package_name…

yum remove package_name…Exemple 8.13. Supprimer plusieurs paquets

yum remove totem

~]# yum remove toteminstall, remove peut prendre ces arguments :

- noms de paquet

- expressions glob

- listes de fichiers

- ce que le paquet fournit

Avertissement

8.3. Utiliser des groupes de paquets

yum groups est une commande de haut niveau qui couvre toutes les opérations agissant sur les groupes de paquets dans yum.

8.3.1. Répertorier les groupes de paquets

summary (résumé) est utilisée pour afficher le nombre de groupes installés, les groupes disponibles, les groupes d'environnement disponibles, ainsi que les deux groupes de langues disponibles et installés :

yum groups summary

yum groups summaryExemple 8.14. Exemple de sortie de résumé des groupes yum

list. Vous pouvez également filtrer la sortie de la commande par nom de groupe.

yum group list glob_expression…

yum group list glob_expression…hidden pour répertorier les groupes qui ne sont pas marqués comme étant visibles par les utilisateurs, et ids pour répertorier les ID de groupe. Vous pouvez ajouter les options language, environment, installed, ou available pour réduire la sortie de la commande à un type de groupe spécifique.

yum group info glob_expression…

yum group info glob_expression…Exemple 8.15. Afficher des informations sur le groupe de paquets LibreOffice

- «

-» — le paquet n'est pas installé et ne sera pas installé comme s'il faisait partie du groupe de paquets. - «

+» — le paquet n'est pas installé mais sera installé lors de la prochaine mise à niveauyum upgradeouyum group upgrade. - «

=» — le paquet est installé et a été installé en faisant partie du groupe de paquets. - « no symbol » — le paquet est installé mais il a été installé hors du groupe de paquets. Cela signifie que

yum group removene supprimera pas ce paquet.

group_command est défini sur objects, qui est le paramètre par défaut. Définissez ce paramètre sur une autre valeur si vous ne souhaitez pas que yum vérifie si un paquet a été installé en tant que faisant partie d'un groupe ou séparément, ce qui rendra les paquets « no symbol » équivalents aux paquets « = ».

yum group mark. Par exemple, yum group mark packages marque les paquets installés donnés en tant que membre d'un groupe spécifié. Pour éviter l'installation de nouveaux paquets sur une mise à jour de groupe, veuillez utiliser yum group mark blacklist. Consultez la page man de yum(8) pour obtenir davantage d'informations sur les capacités de yum group mark.

Note

yum group list, info, install, ou remove, veuillez inclure @group_name pour spécifier un groupe de paquets, @^group_name pour spécifier un groupe environnemental, ou group_name pour inclure les deux.

8.3.2. Installer un groupe de paquets

yum group list ids

yum group list ids Exemple 8.16. Trouver le nom et l'ID de groupe d'un groupe de paquets

yum group list ids kde\* Available environment groups: KDE Plasma Workspaces (kde-desktop-environment) Done