Ce contenu n'est pas disponible dans la langue sélectionnée.

Configuring and managing virtualization

Setting up your host, creating and administering virtual machines, and understanding virtualization features

Abstract

- What the capabilities and use cases of virtualization are

- How to manage your host and your virtual machines by using command-line utilities, as well as by using the web console

- What the support limitations of virtualization are on various system architectures, such as Intel 64, AMD64, and IBM Z

Providing feedback on Red Hat documentation

We are committed to providing high-quality documentation and value your feedback. To help us improve, you can submit suggestions or report errors through the Red Hat Jira tracking system.

Procedure

Log in to the Jira website.

If you do not have an account, select the option to create one.

- Click Create in the top navigation bar.

- Enter a descriptive title in the Summary field.

- Enter your suggestion for improvement in the Description field. Include links to the relevant parts of the documentation.

- Click Create at the bottom of the dialogue.

Chapter 1. Introducing virtualization in RHEL

If you are unfamiliar with the concept of virtualization or its implementation in Linux, the following sections provide a general overview of virtualization in RHEL 9: its basics, advantages, components, and other possible virtualization solutions provided by Red Hat.

1.1. What is virtualization?

RHEL 9 provides the virtualization functionality, which enables a machine running RHEL 9 to host multiple virtual machines (VMs), also referred to as guests. VMs use the host’s physical hardware and computing resources to run a separate, virtualized operating system (guest OS) as a user-space process on the host’s operating system.

In other words, virtualization makes it possible to have operating systems within operating systems.

VMs enable you to safely test software configurations and features, run legacy software, or optimize the workload efficiency of your hardware. For more information about the benefits, see Advantages of virtualization.

For more information about what virtualization is, see the Virtualization topic page.

Next steps

- To start using virtualization in Red Hat Enterprise Linux 9, see Enabling virtualization in Red Hat Enterprise Linux 9.

- In addition to Red Hat Enterprise Linux 9 virtualization, Red Hat offers a number of specialized virtualization solutions, each with a different user focus and features. For more information, see Red Hat virtualization solutions.

1.2. Advantages of virtualization

Using virtual machines (VMs) has the following benefits in comparison to using physical machines:

Flexible and fine-grained allocation of resources

A VM runs on a host machine, which is usually physical, and physical hardware can also be assigned for the guest OS to use. However, the allocation of physical resources to the VM is done on the software level, and is therefore very flexible. A VM uses a configurable fraction of the host memory, CPUs, or storage space, and that configuration can specify very fine-grained resource requests.

For example, what the guest OS sees as its disk can be represented as a file on the host file system, and the size of that disk is less constrained than the available sizes for physical disks.

Software-controlled configurations

The entire configuration of a VM is saved as data on the host, and is under software control. Therefore, a VM can easily be created, removed, cloned, migrated, operated remotely, or connected to remote storage.

Separation from the host

A guest OS runs on a virtualized kernel, separate from the host OS. This means that any OS can be installed on a VM, and even if the guest OS becomes unstable or is compromised, the host is not affected in any way.

Space and cost efficiency

A single physical machine can host a large number of VMs. Therefore, it avoids the need for multiple physical machines to do the same tasks, and thus lowers the space, power, and maintenance requirements associated with physical hardware.

Software compatibility

Because a VM can use a different OS than its host, virtualization makes it possible to run applications that were not originally released for your host OS. For example, using a RHEL 7 guest OS, you can run applications released for RHEL 7 on a RHEL 9 host system.

NoteNot all operating systems are supported as a guest OS in a RHEL 9 host. For details, see Recommended features in RHEL 9 virtualization.

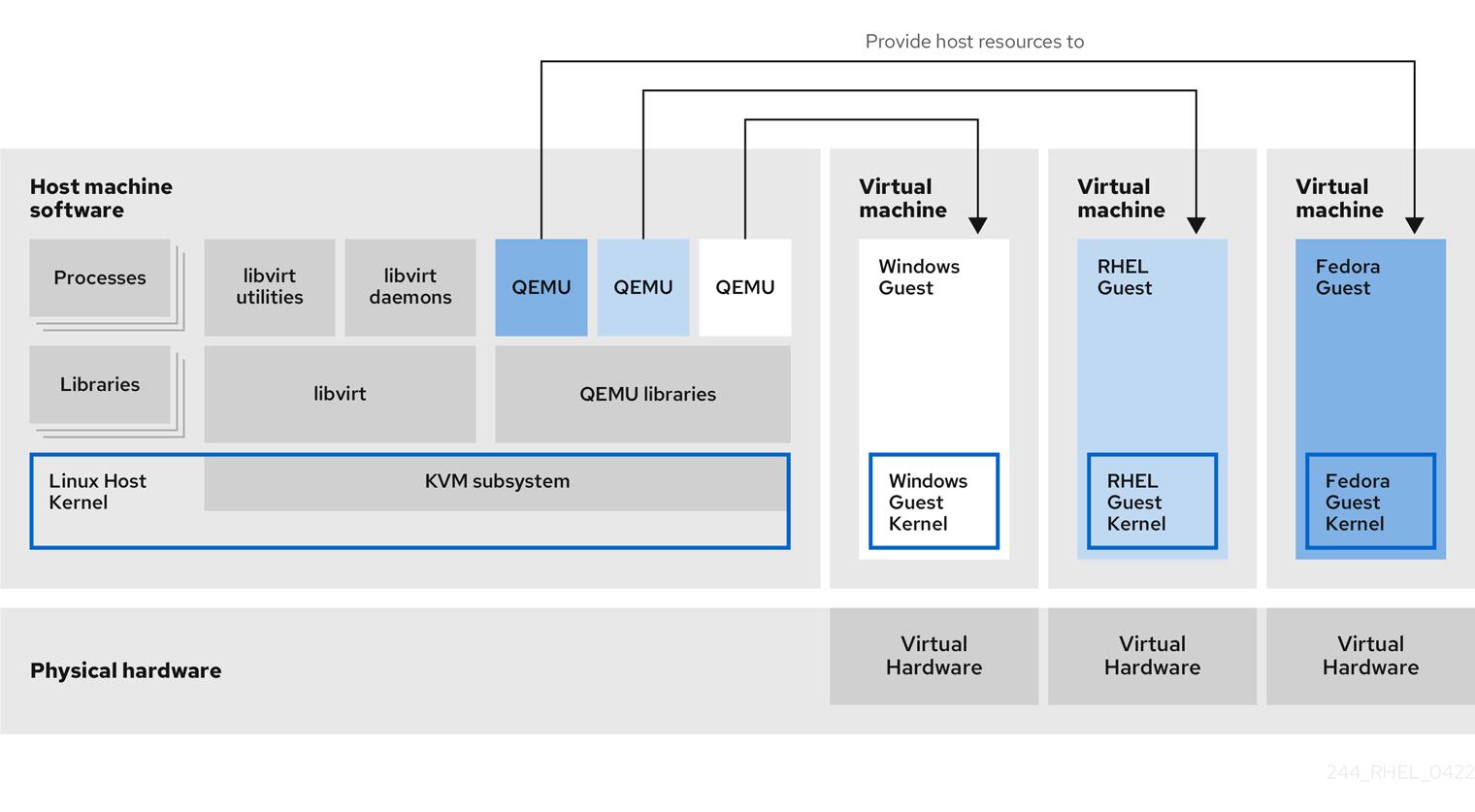

1.3. Virtual machine components and their interaction

Virtualization in RHEL 9 consists of the following principal software components:

Hypervisor

The basis of creating virtual machines (VMs) in RHEL 9 is the hypervisor, a software layer that controls hardware and enables running multiple operating systems on a host machine.

The hypervisor includes the Kernel-based Virtual Machine (KVM) module and virtualization kernel drivers. These components ensure that the Linux kernel on the host machine provides resources for virtualization to user-space software.

At the user-space level, the QEMU emulator simulates a complete virtualized hardware platform that the guest operating system can run in, and manages how resources are allocated on the host and presented to the guest.

In addition, the libvirt software suite serves as a management and communication layer, making QEMU easier to interact with, enforcing security rules, and providing a number of additional tools for configuring and running VMs.

XML configuration

A host-based XML configuration file (also known as a domain XML file) determines all settings and devices in a specific VM. The configuration includes:

- Metadata such as the name of the VM, time zone, and other information about the VM.

- A description of the devices in the VM, including virtual CPUs (vCPUS), storage devices, input/output devices, network interface cards, and other hardware, real and virtual.

- VM settings such as the maximum amount of memory it can use, restart settings, and other settings about the behavior of the VM.

For more information about the contents of an XML configuration, see Sample virtual machine XML configuration.

Component interaction

When a VM is started, the hypervisor uses the XML configuration to create an instance of the VM as a user-space process on the host. The hypervisor also makes the VM process accessible to the host-based interfaces, such as the virsh, virt-install, and guestfish utilities, or the web console GUI.

When these virtualization tools are used, libvirt translates their input into instructions for QEMU. QEMU communicates the instructions to KVM, which ensures that the kernel appropriately assigns the resources necessary to carry out the instructions. As a result, QEMU can execute the corresponding user-space changes, such as creating or modifying a VM, or performing an action in the VM’s guest operating system.

While QEMU is an essential component of the architecture, it is not intended to be used directly on RHEL 9 systems, due to security concerns. Therefore, qemu-* commands are not supported by Red Hat, and it is highly recommended to interact with QEMU by using libvirt.

For more information about the host-based interfaces, see Tools and interfaces for virtualization management.

Figure 1.1. RHEL 9 virtualization architecture

1.4. Tools and interfaces for virtualization management

You can manage virtualization in RHEL 9 by using the command line (CLI) or several graphical user interfaces (GUIs).

Command-line interface

The CLI is the most powerful method of managing virtualization in RHEL 9. Prominent CLI commands for virtual machine (VM) management include:

virsh - A versatile virtualization command-line utility and shell with a great variety of purposes, depending on the provided arguments. For example:

-

Starting and shutting down a VM -

virsh startandvirsh shutdown -

Listing available VMs -

virsh list -

Creating a VM from a configuration file -

virsh create -

Entering a virtualization shell -

virsh

For more information, see the

virsh(1)man page on your system.-

Starting and shutting down a VM -

-

virt-install- A CLI utility for creating new VMs. For more information, see thevirt-install(1)man page on your system. -

virt-xml- A utility for editing the configuration of a VM. -

guestfish- A utility for examining and modifying VM disk images. For more information, see theguestfish(1)man page on your system.

Graphical interfaces

You can use the following GUIs to manage virtualization in RHEL 9:

The RHEL 9 web console, also known as Cockpit, provides a remotely accessible and easy to use graphical user interface for managing VMs and virtualization hosts.

For instructions on basic virtualization management with the web console, see Managing virtual machines in the web console.

1.5. Red Hat virtualization solutions

The following Red Hat products are built on top of RHEL 9 virtualization features and expand the KVM virtualization capabilities available in RHEL 9. In addition, many limitations of RHEL 9 virtualization do not apply to these products:

- OpenShift Virtualization

Based on the KubeVirt technology, OpenShift Virtualization is a part of the Red Hat OpenShift Container Platform, and makes it possible to run virtual machines in containers.

For more information about OpenShift Virtualization see the Red Hat Hybrid Cloud pages.

- Red Hat OpenStack Platform (RHOSP)

Red Hat OpenStack Platform offers an integrated foundation to create, deploy, and scale a secure and reliable public or private OpenStack cloud.

For more information about Red Hat OpenStack Platform, see the Red Hat Customer Portal or the Red Hat OpenStack Platform documentation suite.

For details on virtualization features not supported in RHEL but supported in other Red Hat virtualization solutions, see: Unsupported features in RHEL 9 virtualization

Chapter 2. Enabling virtualization

To use virtualization in RHEL 9, you must install virtualization packages and ensure your system is configured to host virtual machines (VMs). The specific steps to do this vary based on your CPU architecture.

2.1. Enabling virtualization on AMD64 and Intel 64

To set up a KVM hypervisor and create virtual machines (VMs) on an AMD64 or Intel 64 system running RHEL 9, follow the instructions below.

Prerequisites

- Red Hat Enterprise Linux 9 is installed and registered on your host machine.

Your system meets the following hardware requirements to work as a virtualization host:

- The architecture of your host machine supports KVM virtualization.

The following minimum system resources are available:

- 6 GB free disk space for the host, plus another 6 GB for each intended VM.

- 2 GB of RAM for the host, plus another 2 GB for each intended VM.

- 4 CPUs on the host. VMs can generally run with a single assigned vCPU, but Red Hat recommends assigning 2 or more vCPUs per VM to avoid VMs becoming unresponsive during high load.

Procedure

Install the virtualization hypervisor packages.

dnf install qemu-kvm libvirt virt-install virt-viewer

# dnf install qemu-kvm libvirt virt-install virt-viewerCopy to Clipboard Copied! Toggle word wrap Toggle overflow Start the virtualization services:

for drv in qemu network nodedev nwfilter secret storage interface; do systemctl start virt${drv}d{,-ro,-admin}.socket; done# for drv in qemu network nodedev nwfilter secret storage interface; do systemctl start virt${drv}d{,-ro,-admin}.socket; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Verification

Verify that your system is prepared to be a virtualization host:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow If all virt-host-validate checks return a

PASSvalue, your system is prepared for creating VMs.If any of the checks return a

FAILvalue, follow the displayed instructions to fix the problem.If any of the checks return a

WARNvalue, consider following the displayed instructions to improve virtualization capabilities.

Troubleshooting

If KVM virtualization is not supported by your host CPU, virt-host-validate generates the following output:

QEMU: Checking for hardware virtualization: FAIL (Only emulated CPUs are available, performance will be significantly limited)

QEMU: Checking for hardware virtualization: FAIL (Only emulated CPUs are available, performance will be significantly limited)Copy to Clipboard Copied! Toggle word wrap Toggle overflow However, VMs on such a host system will fail to boot, rather than have performance problems.

To work around this, you can change the

<domain type>value in the XML configuration of the VM toqemu. Note, however, that Red Hat does not support VMs that use theqemudomain type, and setting this is highly discouraged in production environments.

2.2. Enabling virtualization on IBM Z

To set up a KVM hypervisor and create virtual machines (VMs) on an IBM Z system running RHEL 9, follow the instructions below.

Prerequisites

The following minimum system resources are available:

- 6 GB free disk space for the host, plus another 6 GB for each intended VM.

- 2 GB of RAM for the host, plus another 2 GB for each intended VM.

- 4 CPUs on the host. VMs can generally run with a single assigned vCPU, but Red Hat recommends assigning 2 or more vCPUs per VM to avoid VMs becoming unresponsive during high load.

- Your IBM Z host system is using an IBM z14 CPU or later.

RHEL 9 is installed on a logical partition (LPAR). In addition, the LPAR supports the start-interpretive execution (SIE) virtualization functions.

To verify this, search for

siein your/proc/cpuinfofile.grep sie /proc/cpuinfo features : esan3 zarch stfle msa ldisp eimm dfp edat etf3eh highgprs te sie

# grep sie /proc/cpuinfo features : esan3 zarch stfle msa ldisp eimm dfp edat etf3eh highgprs te sieCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Procedure

Install the virtualization packages:

dnf install qemu-kvm libvirt virt-install

# dnf install qemu-kvm libvirt virt-installCopy to Clipboard Copied! Toggle word wrap Toggle overflow Start the virtualization services:

for drv in qemu network nodedev nwfilter secret storage interface; do systemctl start virt${drv}d{,-ro,-admin}.socket; done# for drv in qemu network nodedev nwfilter secret storage interface; do systemctl start virt${drv}d{,-ro,-admin}.socket; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Verification

Verify that your system is prepared to be a virtualization host.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow If all virt-host-validate checks return a

PASSvalue, your system is prepared for creating VMs.If any of the checks return a

FAILvalue, follow the displayed instructions to fix the problem.If any of the checks return a

WARNvalue, consider following the displayed instructions to improve virtualization capabilities.

Troubleshooting

If KVM virtualization is not supported by your host CPU, virt-host-validate generates the following output:

QEMU: Checking for hardware virtualization: FAIL (Only emulated CPUs are available, performance will be significantly limited)

QEMU: Checking for hardware virtualization: FAIL (Only emulated CPUs are available, performance will be significantly limited)Copy to Clipboard Copied! Toggle word wrap Toggle overflow However, VMs on such a host system will fail to boot, rather than have performance problems.

To work around this, you can change the

<domain type>value in the XML configuration of the VM toqemu. Note, however, that Red Hat does not support VMs that use theqemudomain type, and setting this is highly discouraged in production environments.

2.3. Enabling virtualization on ARM 64

To set up a KVM hypervisor for creating virtual machines (VMs) on an ARM 64 system (also known as AArch64) that runs RHEL 9, follow the instructions below.

Prerequisites

The following minimum system resources are available:

- 6 GB free disk space for the host, plus another 6 GB for each intended guest.

- 4 GB of RAM for the host, plus another 4 GB for each intended guest.

- 4 CPUs on the host. VMs can generally run with a single assigned vCPU, but Red Hat recommends assigning 2 or more vCPUs per VM to avoid VMs becoming unresponsive during high load.

Procedure

Install the virtualization packages:

dnf install qemu-kvm libvirt virt-install

# dnf install qemu-kvm libvirt virt-installCopy to Clipboard Copied! Toggle word wrap Toggle overflow Start the virtualization services:

for drv in qemu network nodedev nwfilter secret storage interface; do systemctl start virt${drv}d{,-ro,-admin}.socket; done# for drv in qemu network nodedev nwfilter secret storage interface; do systemctl start virt${drv}d{,-ro,-admin}.socket; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Verification

Verify that your system is prepared to be a virtualization host. Run the following command as root:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow If all virt-host-validate checks return a

PASSvalue, your system is prepared for creating virtual machines.If any of the checks return a

FAILvalue, follow the displayed instructions to fix the problem.If any of the checks return a

WARNvalue, consider following the displayed instructions to improve virtualization capabilities.

Next steps

2.4. Enabling QEMU Guest Agent features on your virtual machines

To use certain features on a virtual machine (VM) hosted on your RHEL 9 system, you must first configure the VM to use the QEMU Guest Agent (GA).

For a complete list of these features, see Virtualization features that require QEMU Guest Agent.

The specific steps required to configure QEMU GA on a VM differ based on the guest operating system used by the VM:

- For Linux VMs, see Enabling QEMU Guest Agent on Linux guests.

- For Windows VMs, see Enabling QEMU Guest Agent on Windows guests.

2.4.1. Enabling QEMU Guest Agent on Linux guests

To allow a RHEL host to perform a certain subset of operations on a Linux virtual machine (VM), you must enable the QEMU Guest Agent (GA).

You can enable QEMU GA both on running and shut-down VMs.

Procedure

Create an XML configuration file for the QEMU GA, for example named

qemuga.xml:touch qemuga.xml

# touch qemuga.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Add the following lines to the file:

<channel type='unix'> <source mode='bind' path='/var/lib/libvirt/qemu/f16x86_64.agent'/> <target type='virtio' name='org.qemu.guest_agent.0'/> </channel>

<channel type='unix'> <source mode='bind' path='/var/lib/libvirt/qemu/f16x86_64.agent'/> <target type='virtio' name='org.qemu.guest_agent.0'/> </channel>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Use the XML file to add QEMU GA to the configuration of the VM.

If the VM is running, use the following command:

virsh attach-device <vm-name> qemuga.xml --live --config

# virsh attach-device <vm-name> qemuga.xml --live --configCopy to Clipboard Copied! Toggle word wrap Toggle overflow If the VM is shut-down, use the following command:

virsh attach-device <vm-name> qemuga.xml --config

# virsh attach-device <vm-name> qemuga.xml --configCopy to Clipboard Copied! Toggle word wrap Toggle overflow

In the Linux guest operating system, install the QEMU GA:

dnf install qemu-guest-agent

# dnf install qemu-guest-agentCopy to Clipboard Copied! Toggle word wrap Toggle overflow Start the QEMU GA service on the guest:

systemctl start qemu-guest-agent

# systemctl start qemu-guest-agentCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Verification

To ensure that QEMU GA is enabled and running on the Linux VM, do any of the following:

-

In the guest operating system, use the

systemctl status qemu-guest-agent | grep Loadedcommand. If the output includesenabled, QEMU GA is active on the VM. -

Use the

virsh domfsinfo <vm-name>command on the host. If it displays any output, QEMU GA is active on the specified VM.

2.4.2. Enabling QEMU Guest Agent on Windows guests

To allow a RHEL host to perform a certain subset of operations on a Windows virtual machine (VM), you must enable the QEMU Guest Agent (GA). To do so, add a storage device that contains the QEMU Guest Agent installer to an existing VM or when creating a new VM, and install the drivers on the Windows guest operating system.

To install the Guest Agent (GA) by using the graphical interface, see the procedure below. To install the GA on the command line, use the Microsoft Windows Installer (MSI).

Prerequisites

- An installation medium with the Guest Agent is attached to the VM. For instructions on preparing the medium, see Preparing virtio driver installation media on a host machine.

Procedure

-

In the Windows guest operating system, open the

File Explorerapplication. -

Click

This PC. -

In the

Devices and drivespane, open thevirtio-winmedium. -

Open the

guest-agentfolder. Based on the operating system installed on the VM, run one of the following installers:

-

If using a 32-bit operating system, run the

qemu-ga-i386.msiinstaller. -

If using a 64-bit operating system, run the

qemu-ga-x86_64.msiinstaller.

-

If using a 32-bit operating system, run the

-

Optional: If you want to use the para-virtualized serial driver (

virtio-serial) as the communication interface between the host and the Windows guest, verify that thevirtio-serialdriver is installed on the Windows guest. For more information about installingvirtiodrivers, see: Installing virtio drivers on a Windows guest.

Verification

On your Windows VM, navigate to the Services window.

Computer Management > Services

-

Ensure that the status of the

QEMU Guest Agentservice isRunning.

2.4.3. Virtualization features that require QEMU Guest Agent

If you enable QEMU Guest Agent (GA) on a virtual machine (VM), you can use the following commands on your host to manage the VM:

virsh shutdown --mode=agent-

This shutdown method is more reliable than

virsh shutdown --mode=acpi, becausevirsh shutdownused with QEMU GA is guaranteed to shut down a cooperative guest in a clean state.

virsh domfsfreezeandvirsh domfsthaw- Freezes the guest file system in isolation.

virsh domfstrimInstructs the guest to trim its file system, which helps to reduce the data that needs to be transferred during migrations.

ImportantIf you want to use this command to manage a Linux VM, you must also set the following SELinux boolean in the guest operating system:

setsebool virt_qemu_ga_read_nonsecurity_files on

# setsebool virt_qemu_ga_read_nonsecurity_files onCopy to Clipboard Copied! Toggle word wrap Toggle overflow virsh domtime- Queries or sets the guest’s clock.

virsh setvcpus --guest- Instructs the guest to take CPUs offline, which is useful when CPUs cannot be hot-unplugged.

virsh domifaddr --source agent- Queries the guest operating system’s IP address by using QEMU GA. For example, this is useful when the guest interface is directly attached to a host interface.

virsh domfsinfo- Shows a list of mounted file systems in the running guest.

virsh set-user-password- Sets the password for a given user account in the guest.

virsh set-user-sshkeysEdits the authorized SSH keys file for a given user in the guest.

ImportantIf you want to use this command to manage a Linux VM, you must also set the following SELinux boolean in the guest operating system:

setsebool virt_qemu_ga_manage_ssh on

# setsebool virt_qemu_ga_manage_ssh onCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Chapter 3. Creating virtual machines

To create a virtual machine (VM) in RHEL 9, use the command line or the RHEL 9 web console.

3.1. Creating virtual machines by using the command line

To create a virtual machine (VM) on your RHEL 9 by using the command line, use the virt-install utility.

Prerequisites

- Virtualization is enabled on your host system.

- You have a sufficient amount of system resources to allocate to your VMs, such as disk space, RAM, or CPUs. The recommended values might vary significantly depending on the intended tasks and workload of the VMs.

An operating system (OS) installation source is available locally or on a network. This can be one of the following:

- An ISO image of an installation medium

A disk image of an existing VM installation

WarningInstalling from a host CD-ROM or DVD-ROM device is not possible in RHEL 9. If you select a CD-ROM or DVD-ROM as the installation source when using any VM installation method available in RHEL 9, the installation will fail. For more information, see the Red Hat Knowledgebase solution RHEL 7 or higher can’t install guest OS from CD/DVD-ROM.

Also note that Red Hat provides support only for a limited set of guest operating systems.

- Optional: A Kickstart file can be provided for faster and easier configuration of the installation.

Procedure

To create a VM and start its OS installation, use the virt-install command, along with the following mandatory arguments:

-

--name: the name of the new machine -

--memory: the amount of allocated memory -

--vcpus: the number of allocated virtual CPUs -

--disk: the type and size of the allocated storage -

--cdromor--location: the type and location of the OS installation source --osinfo: the OS type and version that you intend to installNoteTo list all available values for the

--osinfoargument, run thevirt-install --osinfo listcommand.For more details, install the

libosinfo-binpackage and run theosinfo-query oscommand.

Based on the chosen installation method, the necessary options and values can vary. See the commands below for examples:

The following command creates a VM named demo-guest1 that installs the Windows 10 OS from an ISO image locally stored in the /home/username/Downloads/Win10install.iso file. This VM is also allocated with 2048 MiB of RAM and 2 vCPUs, and an 80 GiB qcow2 virtual disk is automatically configured for the VM.

virt-install \ --name demo-guest1 --memory 2048 \ --vcpus 2 --disk size=80 --osinfo win10 \ --cdrom /home/username/Downloads/Win10install.iso# virt-install \ --name demo-guest1 --memory 2048 \ --vcpus 2 --disk size=80 --osinfo win10 \ --cdrom /home/username/Downloads/Win10install.isoCopy to Clipboard Copied! Toggle word wrap Toggle overflow The following command creates a VM named demo-guest2 that uses the /home/username/Downloads/rhel9.iso image to run a RHEL 9 OS from a live CD. No disk space is assigned to this VM, so changes made during the session will not be preserved. In addition, the VM is allocated with 4096 MiB of RAM and 4 vCPUs.

virt-install \ --name demo-guest2 --memory 4096 --vcpus 4 \ --disk none --livecd --osinfo rhel9.0 \ --cdrom /home/username/Downloads/rhel9.iso# virt-install \ --name demo-guest2 --memory 4096 --vcpus 4 \ --disk none --livecd --osinfo rhel9.0 \ --cdrom /home/username/Downloads/rhel9.isoCopy to Clipboard Copied! Toggle word wrap Toggle overflow The following command creates a RHEL 9 VM named demo-guest3 that connects to an existing disk image, /home/username/backup/disk.qcow2. This is similar to physically moving a hard drive between machines, so the OS and data available to demo-guest3 are determined by how the image was handled previously. In addition, this VM is allocated with 2048 MiB of RAM and 2 vCPUs.

virt-install \ --name demo-guest3 --memory 2048 --vcpus 2 \ --os-info rhel9.0 --import \ --disk /home/username/backup/disk.qcow2# virt-install \ --name demo-guest3 --memory 2048 --vcpus 2 \ --os-info rhel9.0 --import \ --disk /home/username/backup/disk.qcow2Copy to Clipboard Copied! Toggle word wrap Toggle overflow The following command creates a VM named demo-guest4 that installs from the

http://example.com/OS-installURL. For the installation to start successfully, the URL must contain a working OS installation tree. In addition, the OS is automatically configured by using the /home/username/ks.cfg kickstart file. This VM is also allocated with 2048 MiB of RAM, 2 vCPUs, and a 160 GiB qcow2 virtual disk.virt-install \ --name demo-guest4 --memory 2048 --vcpus 2 --disk size=160 \ --osinfo rhel9.0 --location http://example.com/OS-install \ --initrd-inject /home/username/ks.cfg --extra-args="inst.ks=file:/ks.cfg console=tty0 console=ttyS0,115200n8"# virt-install \ --name demo-guest4 --memory 2048 --vcpus 2 --disk size=160 \ --osinfo rhel9.0 --location http://example.com/OS-install \ --initrd-inject /home/username/ks.cfg --extra-args="inst.ks=file:/ks.cfg console=tty0 console=ttyS0,115200n8"Copy to Clipboard Copied! Toggle word wrap Toggle overflow In addition, if you want to host demo-guest4 on an RHEL 9 on an ARM 64 host, include the following lines to ensure that the kickstart file installs the

kernel-64kpackage:%packages -kernel kernel-64k %end

%packages -kernel kernel-64k %endCopy to Clipboard Copied! Toggle word wrap Toggle overflow The following command creates a VM named demo-guest5 that installs from a

RHEL9.isoimage file in text-only mode, without graphics. It connects the guest console to the serial console. The VM has 16384 MiB of memory, 16 vCPUs, and 280 GiB disk. This kind of installation is useful when connecting to a host over a slow network link.virt-install \ --name demo-guest5 --memory 16384 --vcpus 16 --disk size=280 \ --osinfo rhel9.0 --location RHEL9.iso \ --graphics none --extra-args='console=ttyS0'# virt-install \ --name demo-guest5 --memory 16384 --vcpus 16 --disk size=280 \ --osinfo rhel9.0 --location RHEL9.iso \ --graphics none --extra-args='console=ttyS0'Copy to Clipboard Copied! Toggle word wrap Toggle overflow The following command creates a VM named demo-guest6, which has the same configuration as demo-guest5, but resides on the 192.0.2.1 remote host.

virt-install \ --connect qemu+ssh://root@192.0.2.1/system --name demo-guest6 --memory 16384 \ --vcpus 16 --disk size=280 --osinfo rhel9.0 --location RHEL9.iso \ --graphics none --extra-args='console=ttyS0'# virt-install \ --connect qemu+ssh://root@192.0.2.1/system --name demo-guest6 --memory 16384 \ --vcpus 16 --disk size=280 --osinfo rhel9.0 --location RHEL9.iso \ --graphics none --extra-args='console=ttyS0'Copy to Clipboard Copied! Toggle word wrap Toggle overflow The following command creates a VM named demo-guest-7, which has the same configuration as demo-guest5, but for its storage, it uses an IBM Z DASD mediated device

mdev_30820a6f_b1a5_4503_91ca_0c10ba12345a_0_0_29a8, and assigns it device number1111.virt-install \ --name demo-guest7 --memory 16384 --vcpus 16 --disk size=280 \ --osinfo rhel9.0 --location RHEL9.iso --graphics none \ --disk none --hostdev mdev_30820a6f_b1a5_4503_91ca_0c10ba12345a_0_0_29a8,address.type=ccw,address.cssid=0xfe,address.ssid=0x0,address.devno=0x1111,boot-order=1 \ --extra-args 'rd.dasd=0.0.1111'# virt-install \ --name demo-guest7 --memory 16384 --vcpus 16 --disk size=280 \ --osinfo rhel9.0 --location RHEL9.iso --graphics none \ --disk none --hostdev mdev_30820a6f_b1a5_4503_91ca_0c10ba12345a_0_0_29a8,address.type=ccw,address.cssid=0xfe,address.ssid=0x0,address.devno=0x1111,boot-order=1 \ --extra-args 'rd.dasd=0.0.1111'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Note that the name of the mediated device available for installation can be retrieved by using the

virsh nodedev-list --cap mdevcommand.The following command creates a VM named demo-guest-8, which has the same configuration as demo-guest5, but provides the host device

pci_0003_00_00_0for networking and configures graphics for a graphical installation.virt-install \ --name demo-guest8 --memory 16384 --vcpus 16 --disk size=280 \ --os-variant rhel9.0 --location RHEL9.iso --graphics vnc,listen=0.0.0.0,5901 \ --input keyboard,bus=virtio --input mouse,bus=virtio \ --hostdev pci_0003_00_00_0 --network none'# virt-install \ --name demo-guest8 --memory 16384 --vcpus 16 --disk size=280 \ --os-variant rhel9.0 --location RHEL9.iso --graphics vnc,listen=0.0.0.0,5901 \ --input keyboard,bus=virtio --input mouse,bus=virtio \ --hostdev pci_0003_00_00_0 --network none'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Note that the name of the host device available for installation can be retrieved by using the

virsh nodedev-list --cap pcicommand. To use the installation GUI, you can connect any VNC viewer to the host’s IP at VNC port 5901 when the installation starts. However, you might have to open this port in the firewall first, for example:firewall-cmd --add-port 5901/tcp

# firewall-cmd --add-port 5901/tcpCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Verification

- If the VM is created successfully, a virt-viewer window opens with a graphical console of the VM and starts the guest OS installation.

Troubleshooting

If

virt-installfails with acannot find default networkerror:Ensure that the

libvirt-daemon-config-networkpackage is installed:{PackageManagerCommand} info libvirt-daemon-config-network Installed Packages Name : libvirt-daemon-config-network [...]# {PackageManagerCommand} info libvirt-daemon-config-network Installed Packages Name : libvirt-daemon-config-network [...]Copy to Clipboard Copied! Toggle word wrap Toggle overflow Verify that the

libvirtdefault network is active and configured to start automatically:virsh net-list --all Name State Autostart Persistent -------------------------------------------- default active yes yes

# virsh net-list --all Name State Autostart Persistent -------------------------------------------- default active yes yesCopy to Clipboard Copied! Toggle word wrap Toggle overflow If it is not, activate the default network and set it to auto-start:

virsh net-autostart default Network default marked as autostarted virsh net-start default Network default started

# virsh net-autostart default Network default marked as autostarted # virsh net-start default Network default startedCopy to Clipboard Copied! Toggle word wrap Toggle overflow If activating the default network fails with the following error, the

libvirt-daemon-config-networkpackage has not been installed correctly.error: failed to get network 'default' error: Network not found: no network with matching name 'default'

error: failed to get network 'default' error: Network not found: no network with matching name 'default'Copy to Clipboard Copied! Toggle word wrap Toggle overflow To fix this, re-install

libvirt-daemon-config-network:{PackageManagerCommand} reinstall libvirt-daemon-config-network# {PackageManagerCommand} reinstall libvirt-daemon-config-networkCopy to Clipboard Copied! Toggle word wrap Toggle overflow If activating the default network fails with an error similar to the following, a conflict has occurred between the default network’s subnet and an existing interface on the host.

error: Failed to start network default error: internal error: Network is already in use by interface ens2

error: Failed to start network default error: internal error: Network is already in use by interface ens2Copy to Clipboard Copied! Toggle word wrap Toggle overflow To fix this, use the

virsh net-edit defaultcommand and change the192.0.2.*values in the configuration to a subnet not already in use on the host.

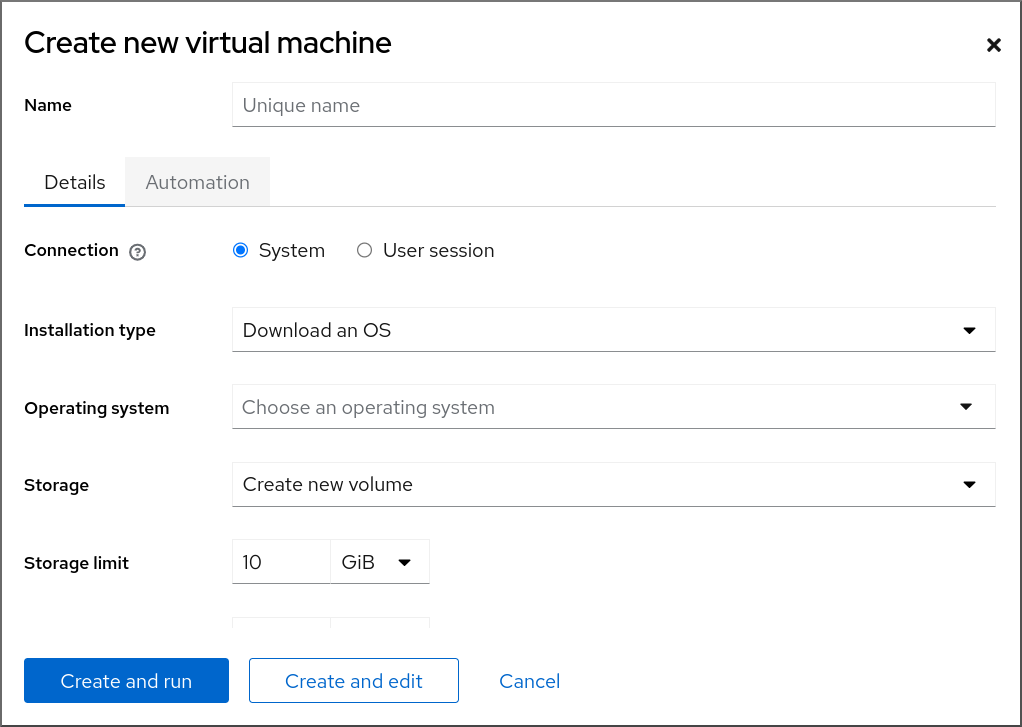

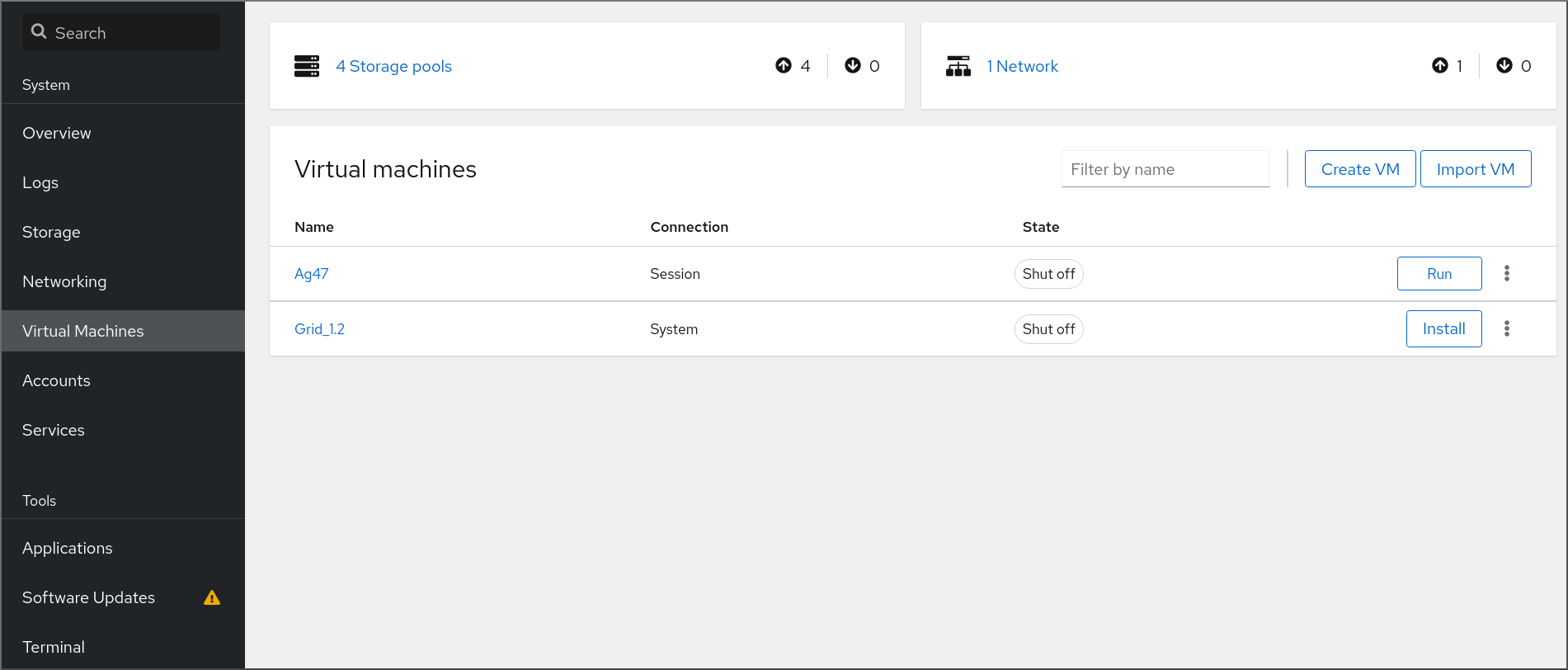

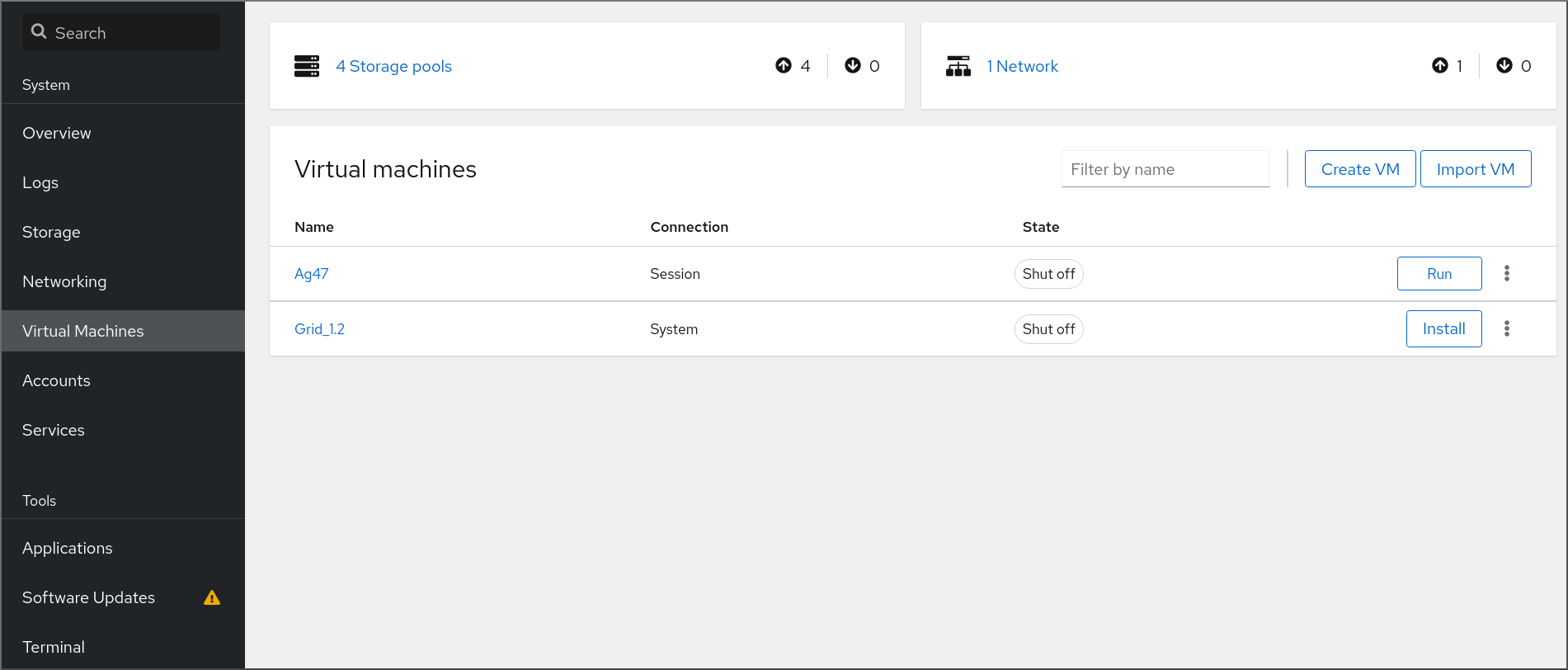

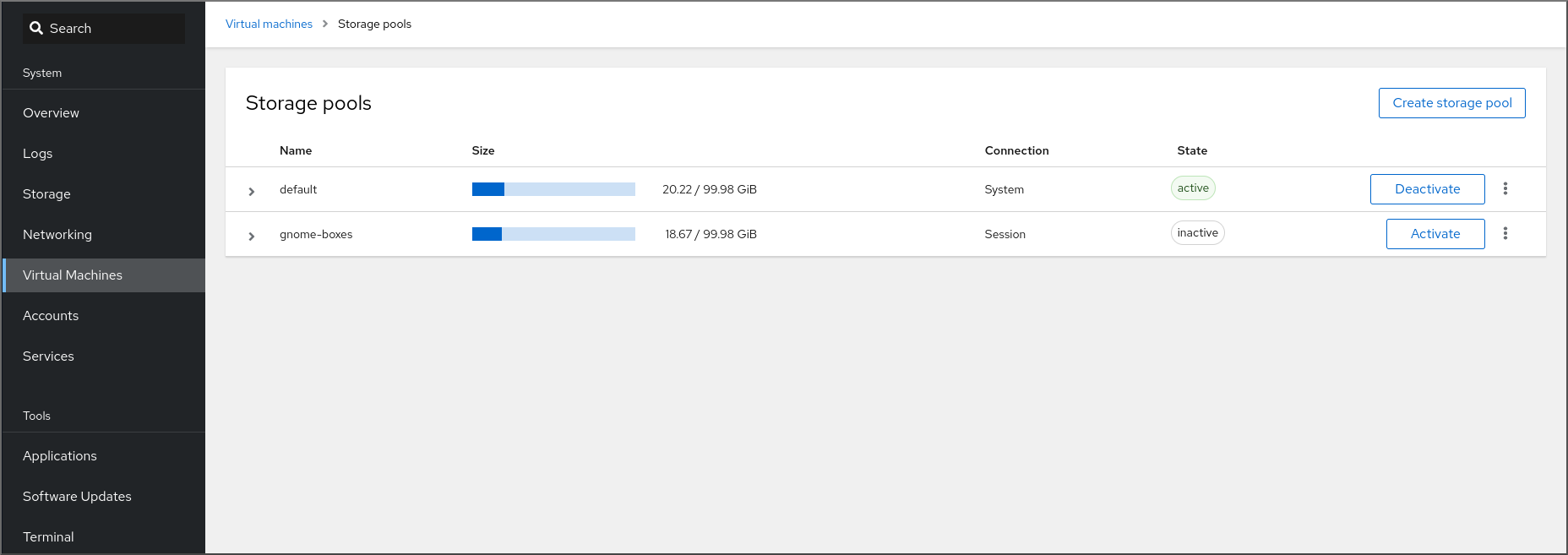

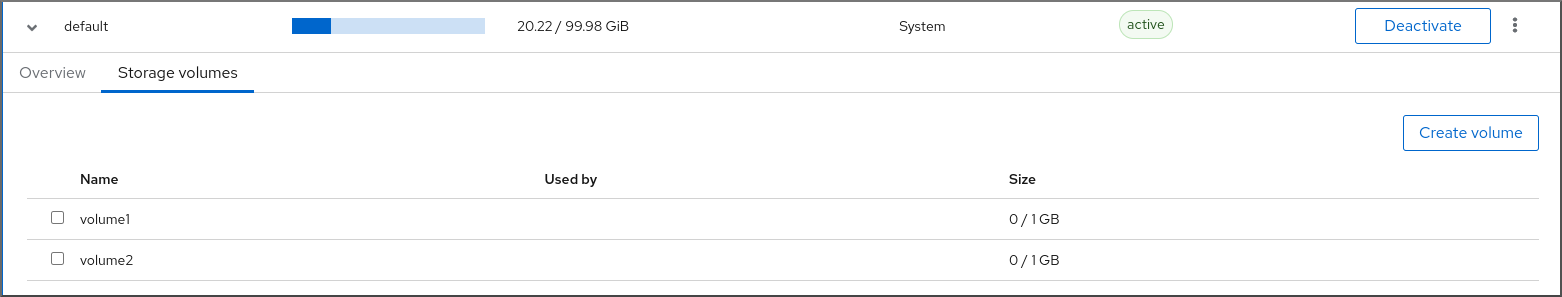

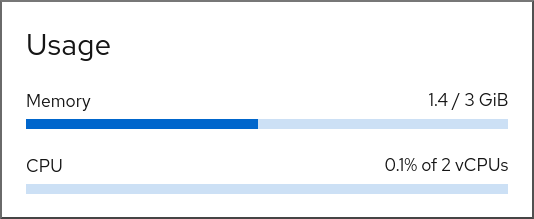

3.2. Creating virtual machines and installing guest operating systems by using the web console

To manage virtual machines (VMs) in a GUI on a RHEL 9 host, use the web console. The following sections provide information about how to use the RHEL 9 web console to create VMs and install guest operating systems on them.

3.2.1. Creating virtual machines by using the web console

To create a virtual machine (VM) on a host machine to which your RHEL 9 web console is connected, use the instructions below.

Prerequisites

- You have installed the RHEL 9 web console.

- You have enabled the cockpit service.

Your user account is allowed to log in to the web console.

For instructions, see Installing and enabling the web console.

- Virtualization is enabled on your host system.

- The web console VM plug-in is installed on your host system.

- You have a sufficient amount of system resources to allocate to your VMs, such as disk space, RAM, or CPUs. The recommended values might vary significantly depending on the intended tasks and workload of the VMs.

Procedure

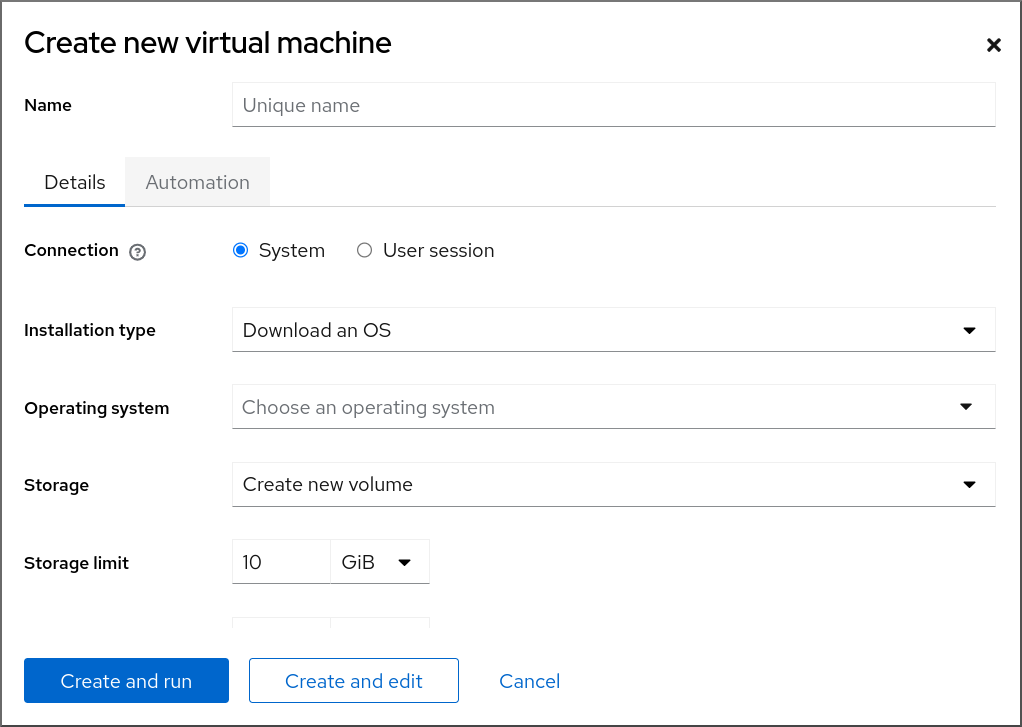

In the Virtual Machines interface of the web console, click .

The Create new virtual machine dialog appears.

Enter the basic configuration of the VM you want to create.

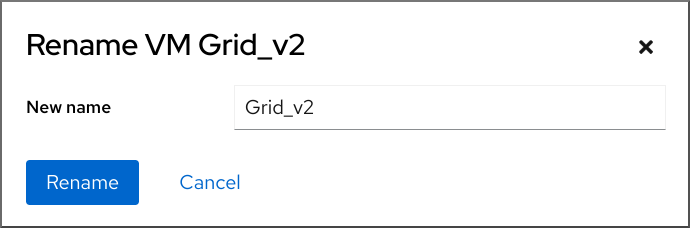

- Name - The name of the VM.

- Connection - The level of privileges granted to the session. For more details, expand the associated dialog box in the web console.

- Installation type - The installation can use a local installation medium, a URL, a PXE network boot, a cloud base image, or download an operating system from a limited set of operating systems.

Operating system - The guest operating system running on the VM. Note that Red Hat provides support only for a limited set of guest operating systems.

NoteTo download and install Red Hat Enterprise Linux directly from web console, you must add an offline token in the Offline token field.

- Storage - The type of storage.

- Storage Limit - The amount of storage space.

- Memory - The amount of memory.

Create the VM:

- If you want the VM to automatically install the operating system, click .

- If you want to edit the VM before the operating system is installed, click .

3.2.2. Creating virtual machines by importing disk images by using the web console

You can create a virtual machine (VM) by importing a disk image of an existing VM installation in the RHEL 9 web console.

Prerequisites

- You have installed the RHEL 9 web console.

- You have enabled the cockpit service.

Your user account is allowed to log in to the web console.

For instructions, see Installing and enabling the web console.

- The web console VM plug-in is installed on your system.

- You have a sufficient amount of system resources to allocate to your VMs, such as disk space, RAM, or CPUs. The recommended values can vary significantly depending on the intended tasks and workload of the VMs.

- You have downloaded a disk image of an existing VM installation.

Procedure

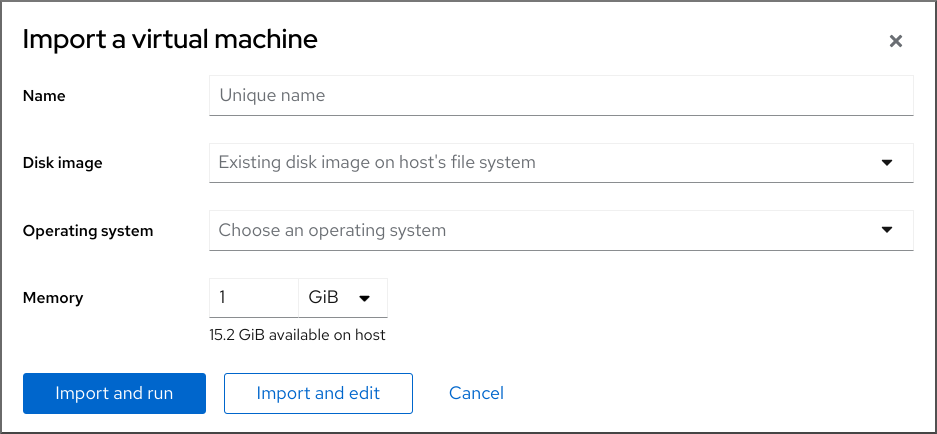

In the Virtual Machines interface of the web console, click .

The Import a virtual machine dialog appears.

Enter the basic configuration of the VM you want to create:

- Name - The name of the VM.

- Disk image - The path to the existing disk image of a VM on the host system.

- Operating system - The operating system running on a VM disk. Note that Red Hat provides support only for a limited set of guest operating systems.

- Memory - The amount of memory to allocate for use by the VM.

Import the VM:

- To install the operating system on the VM without additional edits to the VM settings, click .

- To edit the VM settings before the installation of the operating system, click .

3.2.3. Installing guest operating systems by using the web console

When a virtual machine (VM) boots for the first time, you must install an operating system on the VM.

If you click or while creating a new VM, the installation routine for the operating system starts automatically when the VM is created.

Prerequisites

- You have installed the RHEL 9 web console.

- You have enabled the cockpit service.

Your user account is allowed to log in to the web console.

For instructions, see Installing and enabling the web console.

- The web console VM plug-in is installed on your host system.

Procedure

Log in to the RHEL 9 web console.

For details, see Logging in to the web console.

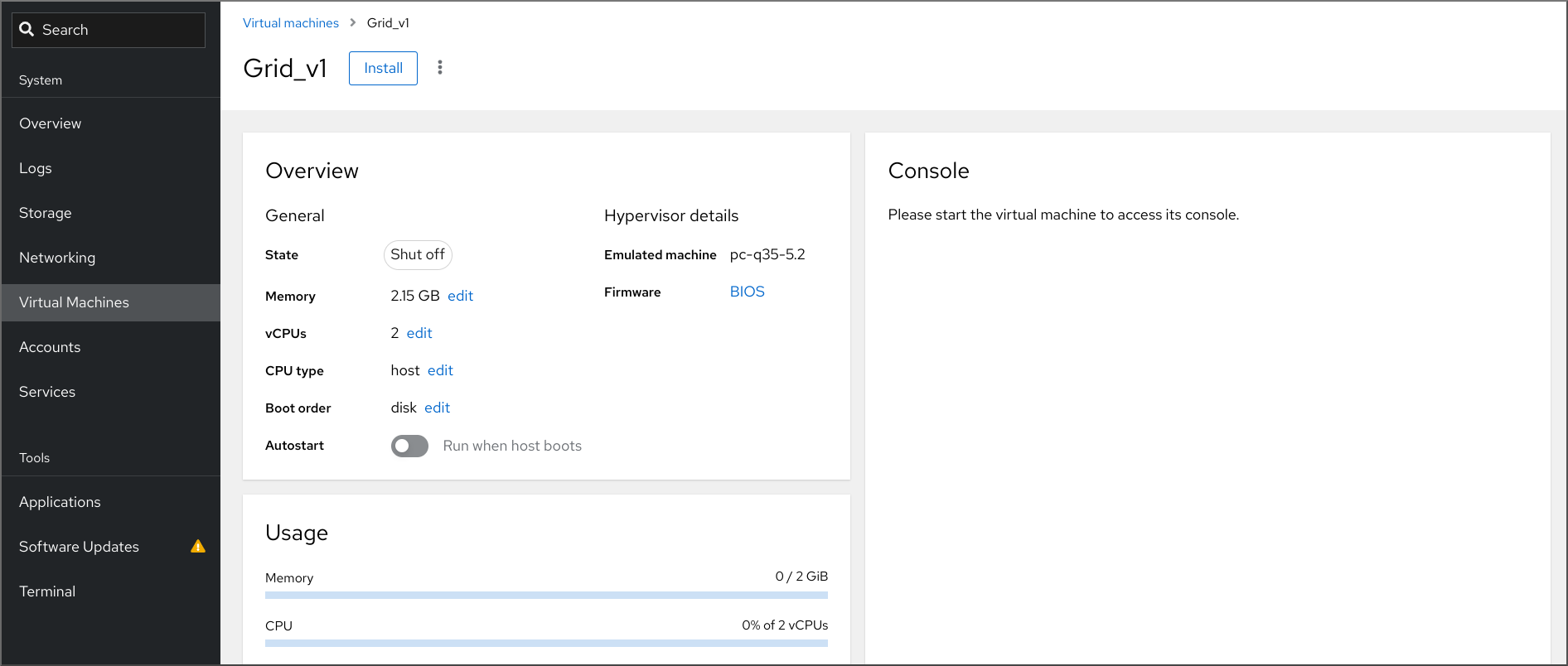

In the Virtual Machines interface, click the VM on which you want to install a guest OS.

A new page opens with basic information about the selected VM and controls for managing various aspects of the VM.

Optional: Change the firmware.

NoteYou can change the firmware only if you selected or while creating a new VM and if the OS is not already installed on the VM.

+ .. Click the firmware.

- In the Change Firmware window, select the required firmware.

- Click .

Click .

The installation routine of the operating system runs in the VM console.

Troubleshooting

- If the installation routine fails, delete and recreate the VM before starting the installation again.

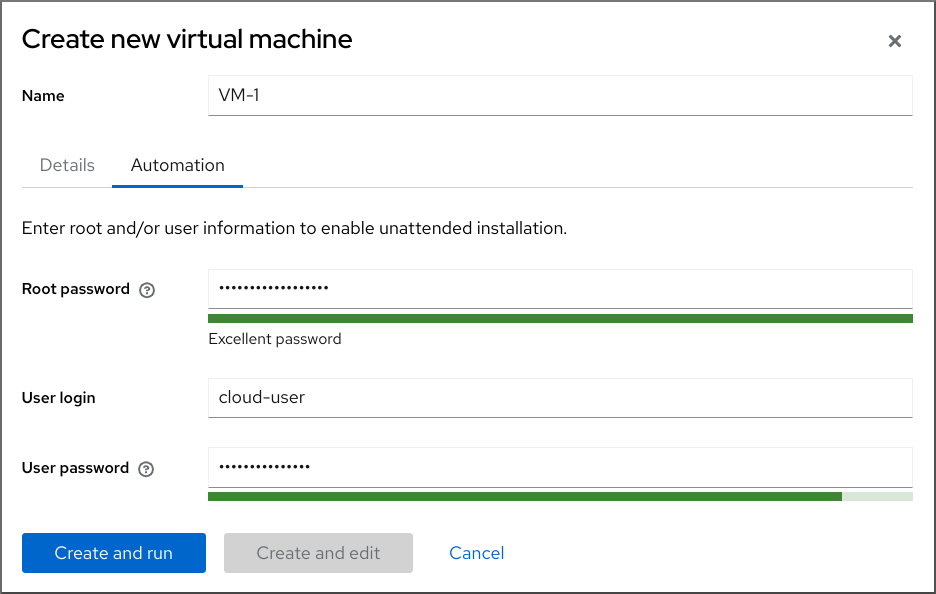

3.2.4. Creating virtual machines with cloud image authentication by using the web console

By default, distro cloud images have no login accounts. However, by using the RHEL web console, you can now create a virtual machine (VM) and specify the root and user account login credentials, which are then passed to cloud-init.

Prerequisites

- You have installed the RHEL 9 web console.

- You have enabled the cockpit service.

Your user account is allowed to log in to the web console.

For instructions, see Installing and enabling the web console.

- The web console VM plug-in is installed on your system.

- Virtualization is enabled on your host system.

- You have a sufficient amount of system resources to allocate to your VMs, such as disk space, RAM, or CPUs. The recommended values may vary significantly depending on the intended tasks and workload of the VMs.

Procedure

Log in to the RHEL 9 web console.

For details, see Logging in to the web console.

In the interface of the web console, click .

The Create new virtual machine dialog appears.

- In the Name field, enter a name for the VM.

On the Details tab, in the Installation type field, select Cloud base image.

- In the Installation source field, set the path to the image file on your host system.

Enter the configuration for the VM that you want to create.

- Operating system - The VM’s operating system. Note that Red Hat provides support only for a limited set of guest operating systems.

- Storage - The type of storage with which to configure the VM.

- Storage Limit - The amount of storage space with which to configure the VM.

- Memory - The amount of memory with which to configure the VM.

Click on the Automation tab.

Set your cloud authentication credentials.

- Root password - Enter a root password for your VM. Leave the field blank if you do not wish to set a root password.

- User login - Enter a cloud-init user login. Leave this field blank if you do not wish to create a user account.

User password - Enter a password. Leave this field blank if you do not wish to create a user account.

Click .

The VM is created.

Chapter 4. Starting virtual machines

To start a virtual machine (VM) in RHEL 9, you can use the command line or the web console GUI.

Prerequisites

- Before a VM can be started, it must be created and, ideally, also installed with an OS. For instruction to do so, see Creating virtual machines.

4.1. Starting a virtual machine by using the command line

You can use the command line (CLI) to start a shut-down virtual machine (VM) or restore a saved VM. By using the CLI, you can start both local and remote VMs.

Prerequisites

- An inactive VM that is already defined.

- The name of the VM.

For remote VMs:

- The IP address of the host where the VM is located.

- Root access privileges to the host.

Procedure

For a local VM, use the

virsh startutility.For example, the following command starts the demo-guest1 VM.

virsh start demo-guest1 Domain 'demo-guest1' started

# virsh start demo-guest1 Domain 'demo-guest1' startedCopy to Clipboard Copied! Toggle word wrap Toggle overflow For a VM located on a remote host, use the

virsh startutility along with the QEMU+SSH connection to the host.For example, the following command starts the demo-guest1 VM on the 192.0.2.1 host.

virsh -c qemu+ssh://root@192.0.2.1/system start demo-guest1 root@192.0.2.1's password: Domain 'demo-guest1' started

# virsh -c qemu+ssh://root@192.0.2.1/system start demo-guest1 root@192.0.2.1's password: Domain 'demo-guest1' startedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2. Starting virtual machines by using the web console

If a virtual machine (VM) is in the shut off state, you can start it by using the RHEL 9 web console. You can also configure the VM to be started automatically when the host starts.

Prerequisites

- You have installed the RHEL 9 web console.

- You have enabled the cockpit service.

Your user account is allowed to log in to the web console.

For instructions, see Installing and enabling the web console.

- The web console VM plug-in is installed on your system.

- An inactive VM that is already defined.

- The name of the VM.

Procedure

In the interface, click the VM you want to start.

A new page opens with detailed information about the selected VM and controls for shutting down and deleting the VM.

Click .

The VM starts, and you can connect to its console or graphical output.

Optional: To configure the VM to start automatically when the host starts, toggle the

Autostartcheckbox in the Overview section.If you use network interfaces that are not managed by libvirt, you must also make additional changes to the systemd configuration. Otherwise, the affected VMs might fail to start, see starting virtual machines automatically when the host starts.

4.3. Starting virtual machines automatically when the host starts

When a host with a running virtual machine (VM) restarts, the VM is shut down, and must be started again manually by default. To ensure a VM is active whenever its host is running, you can configure the VM to be started automatically.

Prerequisites

Procedure

Use the

virsh autostartutility to configure the VM to start automatically when the host starts.For example, the following command configures the demo-guest1 VM to start automatically.

virsh autostart demo-guest1 Domain 'demo-guest1' marked as autostarted

# virsh autostart demo-guest1 Domain 'demo-guest1' marked as autostartedCopy to Clipboard Copied! Toggle word wrap Toggle overflow If you use network interfaces that are not managed by

libvirt, you must also make additional changes to the systemd configuration. Otherwise, the affected VMs might fail to start.NoteThese interfaces include for example:

-

Bridge devices created by

NetworkManager -

Networks configured to use

<forward mode='bridge'/>

In the systemd configuration directory tree, create a

virtqemud.service.ddirectory if it does not exist yet.mkdir -p /etc/systemd/system/virtqemud.service.d/

# mkdir -p /etc/systemd/system/virtqemud.service.d/Copy to Clipboard Copied! Toggle word wrap Toggle overflow Create a

10-network-online.confsystemd unit override file in the previously created directory. The content of this file overrides the default systemd configuration for thevirtqemudservice.touch /etc/systemd/system/virtqemud.service.d/10-network-online.conf

# touch /etc/systemd/system/virtqemud.service.d/10-network-online.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow Add the following lines to the

10-network-online.conffile. This configuration change ensures systemd starts thevirtqemudservice only after the network on the host is ready.[Unit] After=network-online.target

[Unit] After=network-online.targetCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

Bridge devices created by

Verification

View the VM configuration, and check that the autostart option is enabled.

For example, the following command displays basic information about the demo-guest1 VM, including the autostart option.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow If you use network interfaces that are not managed by libvirt, check if the content of the

10-network-online.conffile matches the following output.cat /etc/systemd/system/virtqemud.service.d/10-network-online.conf [Unit] After=network-online.target

$ cat /etc/systemd/system/virtqemud.service.d/10-network-online.conf [Unit] After=network-online.targetCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Chapter 5. Connecting to virtual machines

To interact with a virtual machine (VM) in RHEL 9, you need to connect to it by doing one of the following:

- When using the web console interface, use the Virtual Machines pane in the web console interface. For more information, see Interacting with virtual machines by using the web console.

- If you need to interact with a VM graphical display without using the web console, use the Virt Viewer application. For details, see Opening a virtual machine graphical console by using Virt Viewer.

- When a graphical display is not possible or not necessary, use an SSH terminal connection.

- When the virtual machine is not reachable from your system by using a network, use the virsh console.

If the VMs to which you are connecting are on a remote host rather than a local one, you can optionally configure your system for more convenient access to remote hosts.

5.1. Interacting with virtual machines by using the web console

To interact with a virtual machine (VM) in the RHEL 9 web console, you need to connect to the VM’s console. These include both graphical and serial consoles.

- To interact with the VM’s graphical interface in the web console, use the graphical console.

- To interact with the VM’s graphical interface in a remote viewer, use the graphical console in remote viewers.

- To interact with the VM’s CLI in the web console, use the serial console.

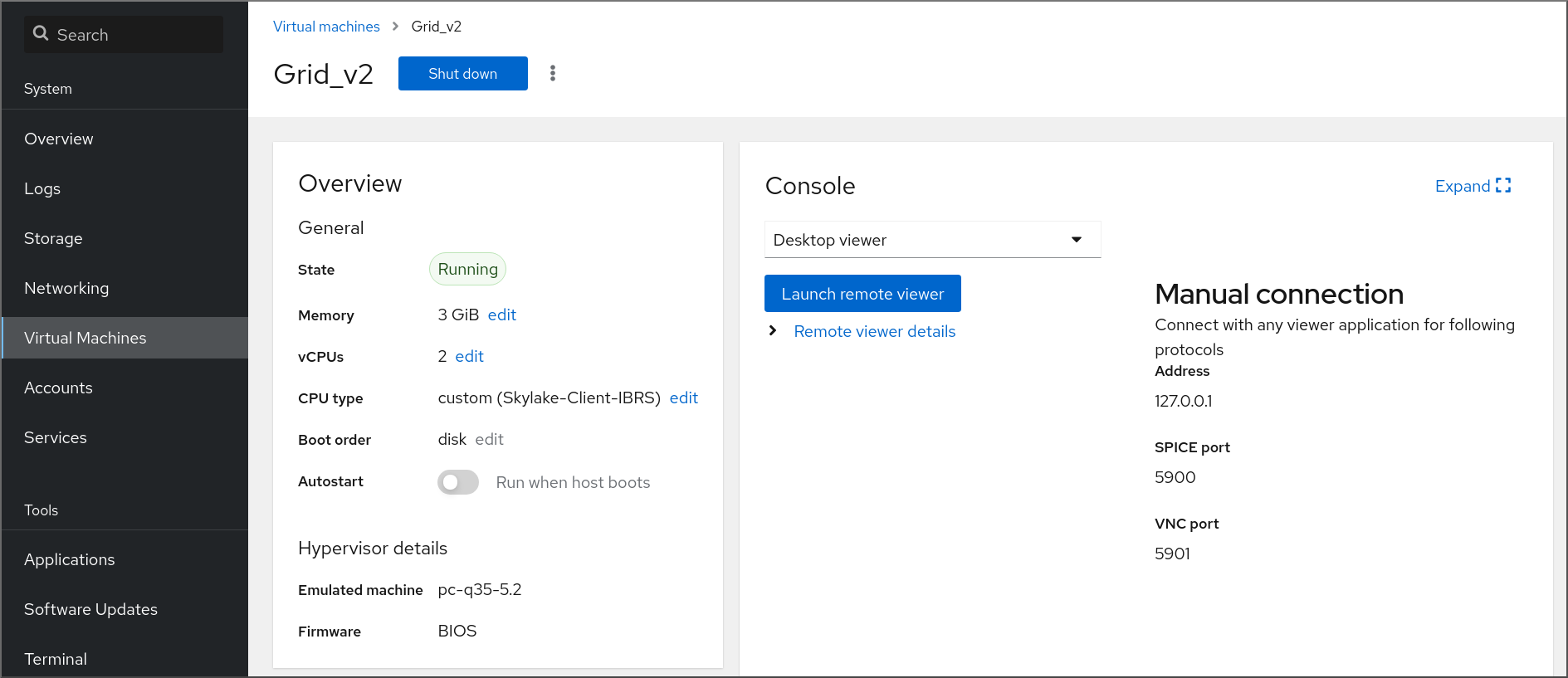

5.1.1. Viewing the virtual machine graphical console in the web console

By using the virtual machine (VM) console interface, you can view the graphical output of a selected VM in the RHEL 9 web console.

Prerequisites

- You have installed the RHEL 9 web console.

- You have enabled the cockpit service.

Your user account is allowed to log in to the web console.

For instructions, see Installing and enabling the web console.

- The web console VM plug-in is installed on your system.

- Ensure that both the host and the VM support a graphical interface.

Procedure

Log in to the RHEL 9 web console.

For details, see Logging in to the web console.

In the interface, click the VM whose graphical console you want to view.

A new page opens with an Overview and a Console section for the VM.

Select in the console drop down menu.

The VNC console appears below the menu in the web interface.

The graphical console appears in the web interface.

Click

You can now interact with the VM console by using the mouse and keyboard in the same manner you interact with a real machine. The display in the VM console reflects the activities being performed on the VM.

The host on which the web console is running may intercept specific key combinations, such as Ctrl+Alt+Del, preventing them from being sent to the VM.

To send such key combinations, click the menu and select the key sequence to send.

For example, to send the Ctrl+Alt+Del combination to the VM, click the and select the menu entry.

Troubleshooting

- If clicking in the graphical console does not have any effect, expand the console to full screen. This is a known issue with the mouse cursor offset.

5.1.2. Viewing the graphical console in a remote viewer by using the web console

By using the web console interface, you can display the graphical console of a selected virtual machine (VM) in a remote viewer, such as Virt Viewer.

You can launch Virt Viewer from within the web console. Other VNC remote viewers can be launched manually.

Prerequisites

- You have installed the RHEL 9 web console.

- You have enabled the cockpit service.

Your user account is allowed to log in to the web console.

For instructions, see Installing and enabling the web console.

- The web console VM plug-in is installed on your system.

- Ensure that both the host and the VM support a graphical interface.

Before you can view the graphical console in Virt Viewer, you must install Virt Viewer on the machine to which the web console is connected.

Click .

The virt viewer,

.vv, file downloads.- Open the file to launch Virt Viewer.

Remote Viewer is available on most operating systems. However, some browser extensions and plug-ins do not allow the web console to open Virt Viewer.

Procedure

Log in to the RHEL 9 web console.

For details, see Logging in to the web console.

In the interface, click the VM whose graphical console you want to view.

A new page opens with an Overview and a Console section for the VM.

Select in the console drop down menu.

Click .

The graphical console opens in Virt Viewer.

You can interact with the VM console by using the mouse and keyboard in the same manner in which you interact with a real machine. The display in the VM console reflects the activities being performed on the VM.

The server on which the web console is running can intercept specific key combinations, such as Ctrl+Alt+Del, preventing them from being sent to the VM.

To send such key combinations, click the menu and select the key sequence to send.

For example, to send the Ctrl+Alt+Del combination to the VM, click the menu and select the menu entry.

Troubleshooting

- If clicking in the graphical console does not have any effect, expand the console to full screen. This is a known issue with the mouse cursor offset.

If launching the Remote Viewer in the web console does not work or is not optimal, you can manually connect with any viewer application by using the following protocols:

-

Address - The default address is

127.0.0.1. You can modify thevnc_listenparameter in/etc/libvirt/qemu.confto change it to the host’s IP address. - VNC port - 5901

-

Address - The default address is

5.1.3. Viewing the virtual machine serial console in the web console

You can view the serial console of a selected virtual machine (VM) in the RHEL 9 web console. This is useful when the host machine or the VM is not configured with a graphical interface.

For more information about the serial console, see Opening a virtual machine serial console.

Prerequisites

- You have installed the RHEL 9 web console.

- You have enabled the cockpit service.

Your user account is allowed to log in to the web console.

For instructions, see Installing and enabling the web console.

- The web console VM plug-in is installed on your system.

Procedure

Log in to the RHEL 9 web console.

For details, see Logging in to the web console.

In the pane, click the VM whose serial console you want to view.

A new page opens with an Overview and a Console section for the VM.

Select in the console drop down menu.

The graphical console appears in the web interface.

You can disconnect and reconnect the serial console from the VM.

- To disconnect the serial console from the VM, click .

- To reconnect the serial console to the VM, click .

5.1.4. Replacing the SPICE remote display protocol with VNC in the web console

The support for the SPICE remote display protocol has been removed on RHEL 9 hosts. If you have a virtual machine (VM) that is configured to use the SPICE protocol, you can replace the SPICE protocol with the VNC protocol by using the web console. Otherwise, the VM fails to start.

However, certain SPICE devices, such as audio and USB passthrough, will be removed from the VM because they do not have a suitable replacement in the VNC protocol. For more information, see Considerations in adopting RHEL 9.

By default, RHEL 8 VMs are configured to use the SPICE protocol. On a RHEL 9 host, these VMs fail to start, if you do not switch from SPICE to VNC.

Prerequisites

- The web console VM plug-in is installed on your system.

- You have an existing VM that is configured to use the SPICE remote display protocol and is already shut-down.

Procedure

In the Virtual Machines interface of the web console, click the Menu button of the VM that is configured to use the SPICE protocol.

A drop down menu opens with controls for various VM operations.

Click .

The Replace SPICE devices dialog opens.

NoteIf you have multiple existing VMs that use the SPICE protocol, they are listed in this dialog. Here, you can select multiple VMs to convert from using SPICE to VNC in a single step.

Click .

A confirmation of the successful operation appears.

Verification

- Click the button to start the VM.

Open the VM overview interface.

If a

VNC consoleoption displays in the Console pane of the interface, the conversion has been successful.

5.2. Opening a virtual machine graphical console by using Virt Viewer

To connect to a graphical console of a KVM virtual machine (VM) and open it in the Virt Viewer desktop application, follow the procedure below.

Prerequisites

- Your system, as well as the VM you are connecting to, must support graphical displays.

- If the target VM is located on a remote host, connection and root access privileges to the host are needed.

- Optional: If the target VM is located on a remote host, set up your libvirt and SSH for more convenient access to remote hosts.

Procedure

To connect to a local VM, use the following command and replace guest-name with the name of the VM you want to connect to:

virt-viewer guest-name

# virt-viewer guest-nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow To connect to a remote VM, use the

virt-viewercommand with the SSH protocol. For example, the following command connects as root to a VM called guest-name, located on remote system 192.0.2.1. The connection also requires root authentication for 192.0.2.1.virt-viewer --direct --connect qemu+ssh://root@192.0.2.1/system guest-name root@192.0.2.1's password:

# virt-viewer --direct --connect qemu+ssh://root@192.0.2.1/system guest-name root@192.0.2.1's password:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Verification

If the connection works correctly, the VM display is shown in the Virt Viewer window.

You can interact with the VM console by using the mouse and keyboard in the same manner you interact with a real machine. The display in the VM console reflects the activities being performed on the VM.

Troubleshooting

- If clicking in the graphical console does not have any effect, expand the console to full screen. This is a known issue with the mouse cursor offset.

5.3. Connecting to a virtual machine by using SSH

To interact with the terminal of a virtual machine (VM) by using the SSH connection protocol, follow the procedure below.

Prerequisites

- You have network connection and root access privileges to the target VM.

- If the target VM is located on a remote host, you also have connection and root access privileges to that host.

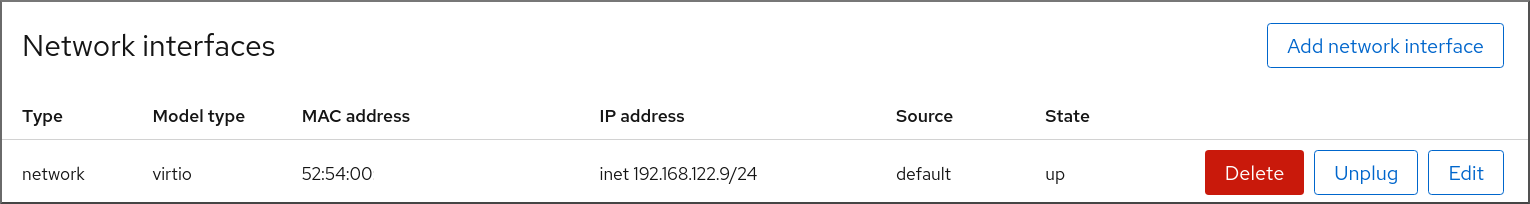

Your VM network assigns IP addresses by

dnsmasqgenerated bylibvirt. This is the case for example inlibvirtNAT networks.Notably, if your VM is using one of the following network configurations, you cannot connect to the VM by using SSH:

-

hostdevinterfaces - Direct interfaces

- Bridge interaces

-

The

libvirt-nsscomponent is installed and enabled on the VM’s host. If it is not, do the following:Install the

libvirt-nsspackage:dnf install libvirt-nss

# dnf install libvirt-nssCopy to Clipboard Copied! Toggle word wrap Toggle overflow Edit the

/etc/nsswitch.conffile and addlibvirt_guestto thehostsline:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Procedure

When connecting to a remote VM, SSH into its physical host first. The following example demonstrates connecting to a host machine

192.0.2.1by using its root credentials:ssh root@192.0.2.1 root@192.0.2.1's password: Last login: Mon Sep 24 12:05:36 2021 root~#

# ssh root@192.0.2.1 root@192.0.2.1's password: Last login: Mon Sep 24 12:05:36 2021 root~#Copy to Clipboard Copied! Toggle word wrap Toggle overflow Use the VM’s name and user access credentials to connect to it. For example, the following connects to the

testguest1VM by using its root credentials:ssh root@testguest1 root@testguest1's password: Last login: Wed Sep 12 12:05:36 2018 root~]#

# ssh root@testguest1 root@testguest1's password: Last login: Wed Sep 12 12:05:36 2018 root~]#Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Troubleshooting

If you do not know the VM’s name, you can list all VMs available on the host by using the

virsh list --allcommand:virsh list --all Id Name State ---------------------------------------------------- 2 testguest1 running - testguest2 shut off

# virsh list --all Id Name State ---------------------------------------------------- 2 testguest1 running - testguest2 shut offCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4. Opening a virtual machine serial console

By using the virsh console command, it is possible to connect to the serial console of a virtual machine (VM).

This is useful when the VM:

- Does not provide VNC protocols, and thus does not offer video display for GUI tools.

- Does not have a network connection, and thus cannot be interacted with using SSH.

Prerequisites

The GRUB boot loader on your host must be configured to use serial console. To verify, check that the

/etc/default/grubfile on your host contains theGRUB_TERMINAL=serialparameter.sudo grep GRUB_TERMINAL /etc/default/grub GRUB_TERMINAL=serial

$ sudo grep GRUB_TERMINAL /etc/default/grub GRUB_TERMINAL=serialCopy to Clipboard Copied! Toggle word wrap Toggle overflow The VM must have a serial console device configured, such as

console type='pty'. To verify, do the following:virsh dumpxml vm-name | grep console <console type='pty' tty='/dev/pts/2'> </console>

# virsh dumpxml vm-name | grep console <console type='pty' tty='/dev/pts/2'> </console>Copy to Clipboard Copied! Toggle word wrap Toggle overflow The VM must have the serial console configured in its kernel command line. To verify this, the

cat /proc/cmdlinecommand output on the VM should include console=<console-name>, where <console-name> is architecture-specific:-

For AMD64 and Intel 64:

ttyS0 For ARM 64:

ttyAMA0NoteThe following commands in this procedure use

ttyS0.cat /proc/cmdline BOOT_IMAGE=/vmlinuz-3.10.0-948.el7.x86_64 root=/dev/mapper/rhel-root ro console=tty0 console=ttyS0,9600n8 rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgb

# cat /proc/cmdline BOOT_IMAGE=/vmlinuz-3.10.0-948.el7.x86_64 root=/dev/mapper/rhel-root ro console=tty0 console=ttyS0,9600n8 rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgbCopy to Clipboard Copied! Toggle word wrap Toggle overflow If the serial console is not set up properly on a VM, using virsh console to connect to the VM connects you to an unresponsive guest console. However, you can still exit the unresponsive console by using the Ctrl+] shortcut.

To set up serial console on the VM, do the following:

On the VM, enable the

console=ttyS0kernel option:grubby --update-kernel=ALL --args="console=ttyS0"

# grubby --update-kernel=ALL --args="console=ttyS0"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Clear the kernel options that might prevent your changes from taking effect.

grub2-editenv - unset kernelopts

# grub2-editenv - unset kerneloptsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Reboot the VM.

-

For AMD64 and Intel 64:

The

serial-getty@<console-name>service must be enabled. For example, on AMD64 and Intel 64:systemctl status serial-getty@ttyS0.service ○ serial-getty@ttyS0.service - Serial Getty on ttyS0 Loaded: loaded (/usr/lib/systemd/system/serial-getty@.service; enabled; preset: enabled)# systemctl status serial-getty@ttyS0.service ○ serial-getty@ttyS0.service - Serial Getty on ttyS0 Loaded: loaded (/usr/lib/systemd/system/serial-getty@.service; enabled; preset: enabled)Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Procedure

On your host system, use the

virsh consolecommand. The following example connects to the guest1 VM, if the libvirt driver supports safe console handling:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - You can interact with the virsh console in the same way as with a standard command-line interface.

5.5. Setting up easier access to remote virtualization hosts

When managing VMs on a remote host system by using libvirt utilities, it is recommended to use the -c qemu+ssh://root@hostname/system syntax. For example, to use the virsh list command as root on the 192.0.2.1 host:

However, you can remove the need to specify the connection details in full by modifying your SSH and libvirt configuration. For example:

To enable this improvement, follow the instructions below.

Procedure

Edit the

~/.ssh/configfile with the following details, where host-alias is a shortened name associated with a specific remote host and an alias for root@192.0.2.1, and hosturl is the URL address of the host :vi ~/.ssh/config Host example-host-alias User root Hostname 192.0.2.1

# vi ~/.ssh/config Host example-host-alias User root Hostname 192.0.2.1Copy to Clipboard Copied! Toggle word wrap Toggle overflow Edit the

/etc/libvirt/libvirt.conffile with the following details, the example-qemu-host-alias is a host alias that QEMU and libvirt utilities will associate forqemu+ssh://192.0.2.1/systemwith the intended host example-host-alias :vi /etc/libvirt/libvirt.conf uri_aliases = [ "example-qemu-host-alias=qemu+ssh://example-host-alias/system", ]

# vi /etc/libvirt/libvirt.conf uri_aliases = [ "example-qemu-host-alias=qemu+ssh://example-host-alias/system", ]Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Verification

Confirm that you can manage remote VMs by using libvirt-based utilities on the local system with an added

-c qemu-host-aliasparameter. This automatically performs the commands over SSH on the remote host.For example, verify that the following lists VMs on the 192.0.2.1 remote host, the connection to which was set up as example-qemu-host-alias in the previous steps:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteIn addition to

virsh, the-c(or--connect) option and the remote host access configuration described above can be used by the following utilities:

Next steps

If you want to use libvirt utilities exclusively on a single remote host, you can also set a specific connection as the default target for libvirt-based utilities. However, this is not recommended if you also want to manage VMs on your local host or on different remote hosts.

You can edit the

/etc/libvirt/libvirt.conffile and set the value of theuri_defaultparameter to example-qemu-host-alias as a default libvirt target.# These can be used in cases when no URI is supplied by the application # (@uri_default also prevents probing of the hypervisor driver). # uri_default = "example-qemu-host-alias"

# These can be used in cases when no URI is supplied by the application # (@uri_default also prevents probing of the hypervisor driver). # uri_default = "example-qemu-host-alias"Copy to Clipboard Copied! Toggle word wrap Toggle overflow As a result, all libvirt-based commands will automatically be performed on the specified remote host.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow When connecting to a remote host, you can avoid providing the root password to the remote system. To do so, use one or more of the following methods:

- Set up key-based SSH access to the remote host

- Use SSH connection multiplexing to connect to the remote system **Logging in to IdM in the Web UI: Using a Kerberos ticket

-

The

-c(or--connect) option can be used to run thevirt-install,

virt-viewer, and virsh commands on a remote host.

5.6. Replacing the SPICE remote display protocol with VNC by using the command line

The support for the SPICE remote display protocol has been removed on RHEL 9 hosts. If you have a virtual machine (VM) that is configured to use the SPICE protocol, you can replace the SPICE protocol with the VNC protocol by using the command line. Otherwise, the VM fails to start.

However, certain SPICE devices, such as audio and USB passthrough, will be removed from the VM because they do not have a suitable replacement in the VNC protocol. For more information, see Considerations in adopting RHEL 9.

By default, RHEL 8 VMs are configured to use the SPICE protocol. On a RHEL 9 host, these VMs fail to start, if you do not switch from SPICE to VNC.

Prerequisites

- You have an existing VM that is configured to use the SPICE remote display protocol and is already shut-down.

Procedure

On the host, run the following command, and replace `<vm-name>` with the name of the VM that you want to convert to VNC.

virt-xml <vm-name> --edit --convert-to-vnc Domain 'vm-name' defined successfully

# virt-xml <vm-name> --edit --convert-to-vnc Domain 'vm-name' defined successfullyCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Verification

Inspect the configuration of the VM you converted, and make sure the graphics type is listed as

vnc.virsh dumpxml -xml <vm-name> | grep "graphics" <graphics type='vnc' port='5900' autoport='yes' listen='127.0.0.1'>

# virsh dumpxml -xml <vm-name> | grep "graphics" <graphics type='vnc' port='5900' autoport='yes' listen='127.0.0.1'>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.7. Configuring VNC passwords

To manage access to the graphical output of a virtual machine (VM), you can configure a password for the VNC console of the VM.

With a VNC password configured on a VM, users of the VMs must enter the password when attempting to view or interact with the VNC graphical console of the VMs, for example by using the virt-viewer utility.

VNC passwords are not a sufficient measure for ensuring the security of a VM environment. For details, see QEMU documentation on VNC security.

In addition, the VNC password is saved in plain text in the configuration of the VM, so for the password to be effective, the user must not be able to display the VM configuration.

Prerequisites

The VM that you want to protect with a VNC password has VNC graphics configured.

To ensure that this is the case, use the

virsh dumpxmlcommand as follows:virsh dumpxml <vm-name> | grep graphics <graphics type='vnc' ports='-1' autoport=yes listen=127.0.0.1> </graphics>

# virsh dumpxml <vm-name> | grep graphics <graphics type='vnc' ports='-1' autoport=yes listen=127.0.0.1> </graphics>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Procedure

Open the configuration of the VM that you want to assign a VNC password to.

virsh edit <vm-name>

# virsh edit <vm-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow On the

<graphics>line of the configuration, add thepasswdattribute and the password string. The password must be 8 characters or fewer.<graphics type='vnc' ports='-1' autoport=yes listen=127.0.0.1 passwd='<password>'>

<graphics type='vnc' ports='-1' autoport=yes listen=127.0.0.1 passwd='<password>'>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Optional: In addition, define a date and time when the password will expire.

<graphics type='vnc' ports='-1' autoport=yes listen=127.0.0.1 passwd='<password>' passwdValidTo='2025-02-01T15:30:00'>

<graphics type='vnc' ports='-1' autoport=yes listen=127.0.0.1 passwd='<password>' passwdValidTo='2025-02-01T15:30:00'>Copy to Clipboard Copied! Toggle word wrap Toggle overflow In this example, the password will expire on February 1st 2025, at 15:30 UTC.

- Save the configuration.

Verification

Start the modified VM.

virsh start <vm-name>

# virsh start <vm-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Open a graphical console of the VM, for example by using the

virt-viewerutility:virt-viewer <vm-name>

# virt-viewer <vm-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow If the VNC password has been configured properly, a dialogue window appears that requests you to enter the password.

Chapter 6. Shutting down virtual machines

To shut down a running virtual machine hosted on RHEL 9, use the command line or the web console GUI.

6.1. Shutting down a virtual machine by using the command line

Shutting down a virtual machine (VM) requires different steps based on whether the VM is reponsive.

Shutting down a responsive VM

If you are connected to the guest, use a shutdown command or a GUI element appropriate to the guest operating system.

NoteIn some environments, such as in Linux guests that use the GNOME Desktop, using the GUI power button for suspending or hibernating the guest might instead shut down the VM.

Alternatively, use the

virsh shutdowncommand on the host:If the VM is on a local host:

virsh shutdown demo-guest1 Domain 'demo-guest1' is being shutdown

# virsh shutdown demo-guest1 Domain 'demo-guest1' is being shutdownCopy to Clipboard Copied! Toggle word wrap Toggle overflow If the VM is on a remote host, in this example 192.0.2.1:

virsh -c qemu+ssh://root@192.0.2.1/system shutdown demo-guest1 root@192.0.2.1's password: Domain 'demo-guest1' is being shutdown

# virsh -c qemu+ssh://root@192.0.2.1/system shutdown demo-guest1 root@192.0.2.1's password: Domain 'demo-guest1' is being shutdownCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Shutting down an unresponsive VM

To force a VM to shut down, for example if it has become unresponsive, use the virsh destroy command on the host:

virsh destroy demo-guest1 Domain 'demo-guest1' destroyed

# virsh destroy demo-guest1

Domain 'demo-guest1' destroyed

The virsh destroy command does not actually delete or remove the VM configuration or disk images. It only terminates the running instance of the VM, similarly to pulling the power cord from a physical machine.

In rare cases, virsh destroy may cause corruption of the VM’s file system, so using this command is only recommended if all other shutdown methods have failed.

Verification

On the host, display the list of your VMs to see their status.

virsh list --all Id Name State ------------------------------------------ 1 demo-guest1 shut off

# virsh list --all Id Name State ------------------------------------------ 1 demo-guest1 shut offCopy to Clipboard Copied! Toggle word wrap Toggle overflow

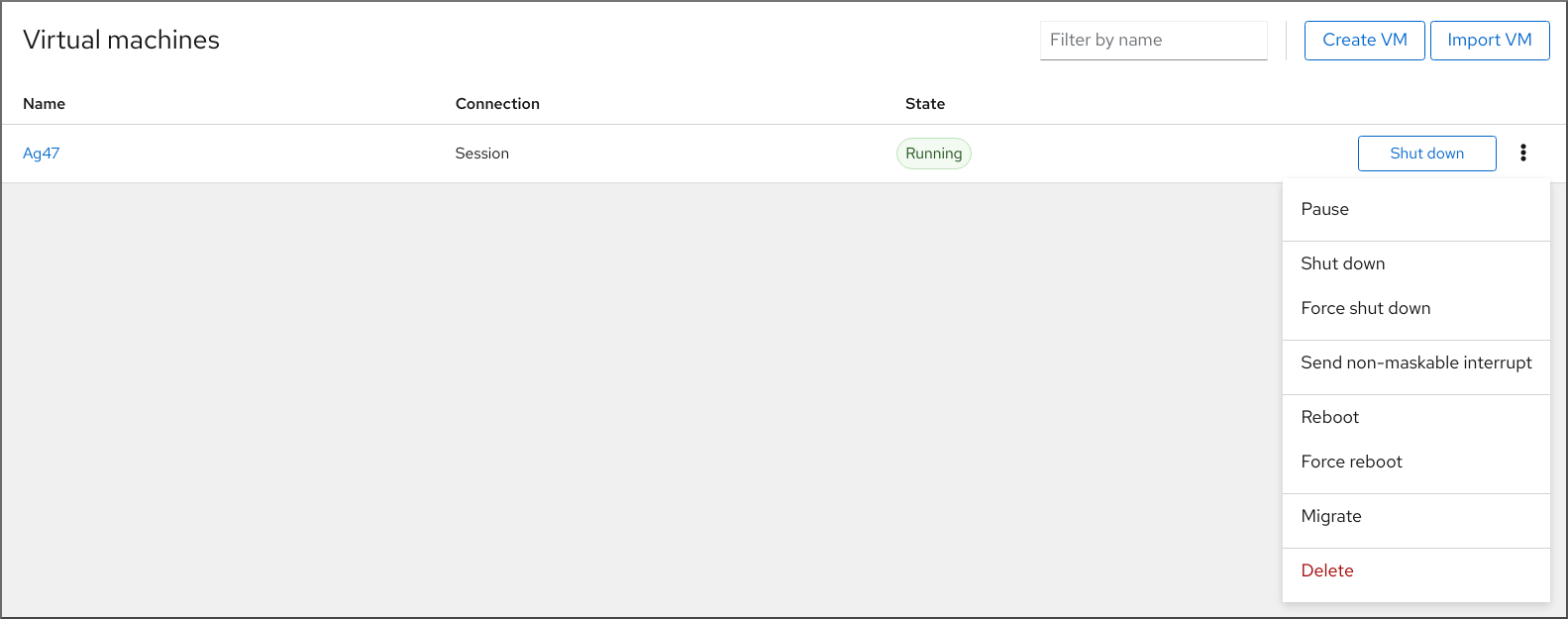

6.2. Shutting down and restarting virtual machines by using the web console

Using the RHEL 9 web console, you can shut down or restart running virtual machines. You can also send a non-maskable interrupt to an unresponsive virtual machine.

6.2.1. Shutting down virtual machines in the web console

If a virtual machine (VM) is in the running state, you can shut it down by using the RHEL 9 web console.

Prerequisites

- You have installed the RHEL 9 web console.

- You have enabled the cockpit service.

Your user account is allowed to log in to the web console.

For instructions, see Installing and enabling the web console.

- The web console VM plug-in is installed on your system.

Procedure

- In the interface, find the row of the VM you want to shut down.

On the right side of the row, click .

The VM shuts down.

Troubleshooting

- If the VM does not shut down, click the Menu button next to the button and select .

- To shut down an unresponsive VM, you can also send a non-maskable interrupt.

6.2.2. Restarting virtual machines by using the web console

If a virtual machine (VM) is in the running state, you can restart it by using the RHEL 9 web console.

Prerequisites

- You have installed the RHEL 9 web console.

- You have enabled the cockpit service.

Your user account is allowed to log in to the web console.

For instructions, see Installing and enabling the web console.

- The web console VM plug-in is installed on your system.

Procedure

- In the interface, find the row of the VM you want to restart.

On the right side of the row, click the Menu button .

A drop-down menu of actions appears.

In the drop-down menu, click .

The VM shuts down and restarts.

Troubleshooting

- If the VM does not restart, click the Menu button next to the button and select .

- To shut down an unresponsive VM, you can also send a non-maskable interrupt.

6.2.3. Sending non-maskable interrupts to VMs by using the web console

Sending a non-maskable interrupt (NMI) may cause an unresponsive running virtual machine (VM) to respond or shut down. For example, you can send the Ctrl+Alt+Del NMI to a VM that is not responding to standard input.

Prerequisites

- You have installed the RHEL 9 web console.

- You have enabled the cockpit service.

Your user account is allowed to log in to the web console.

For instructions, see Installing and enabling the web console.

- The web console VM plug-in is installed on your system.

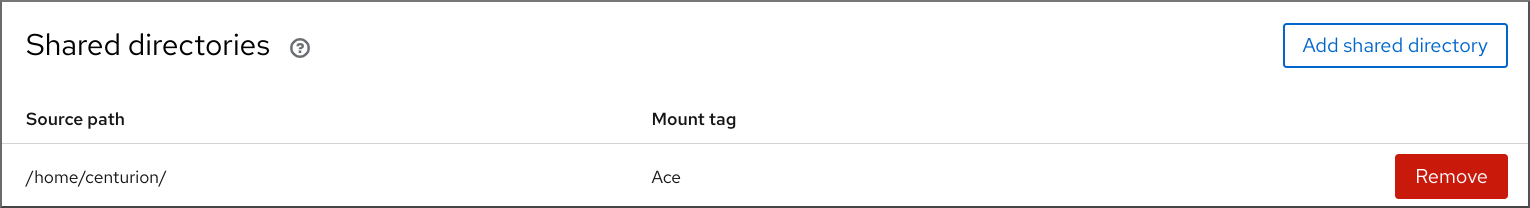

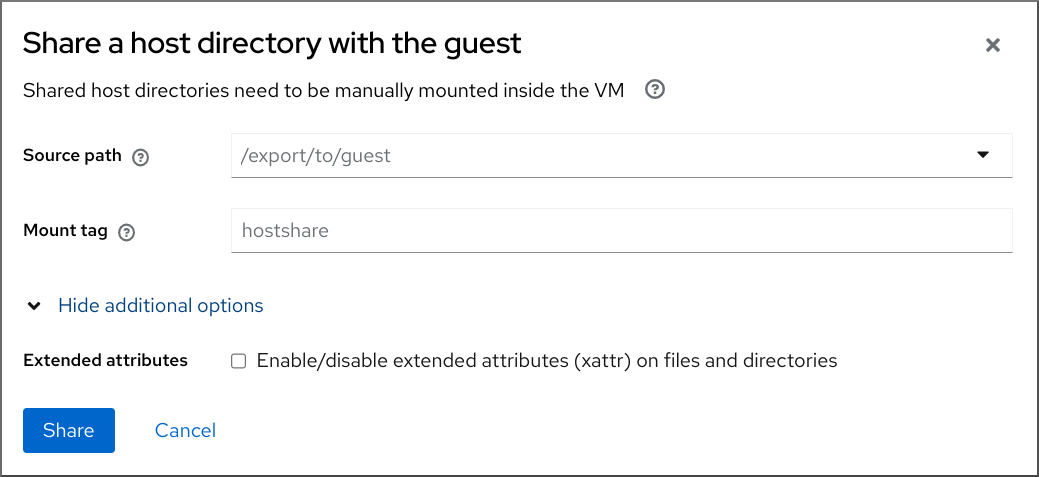

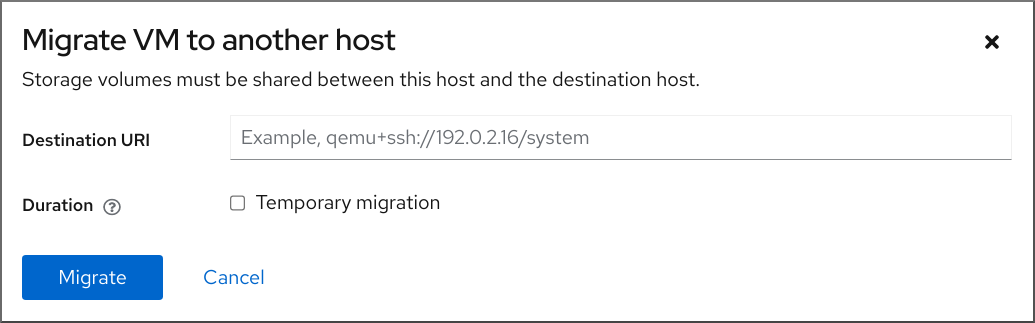

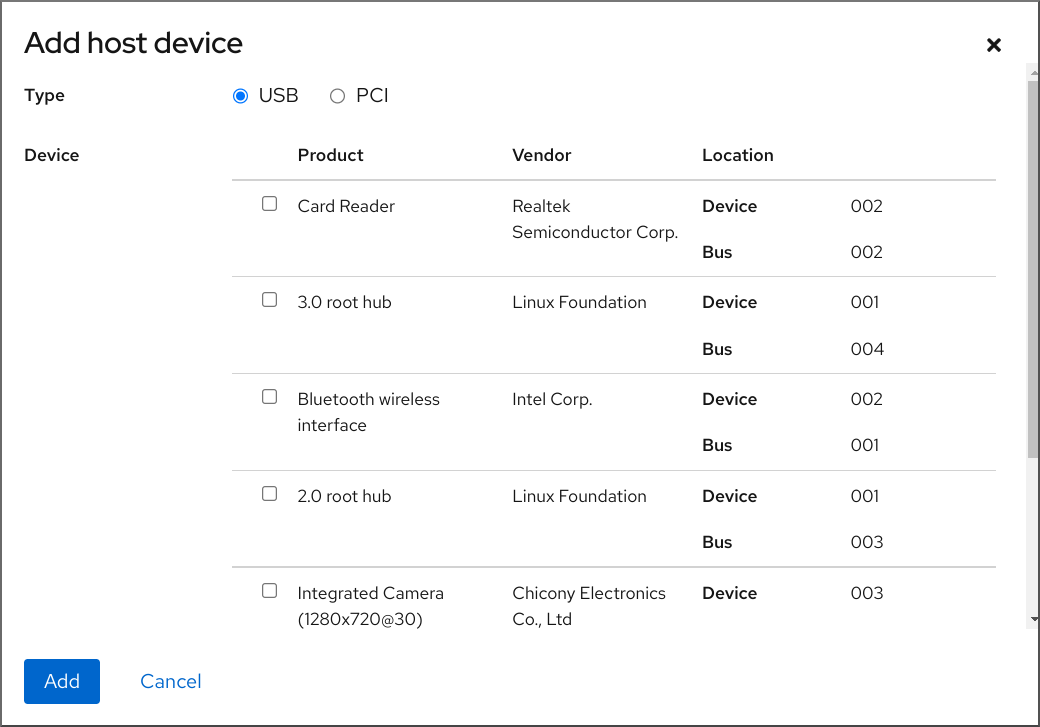

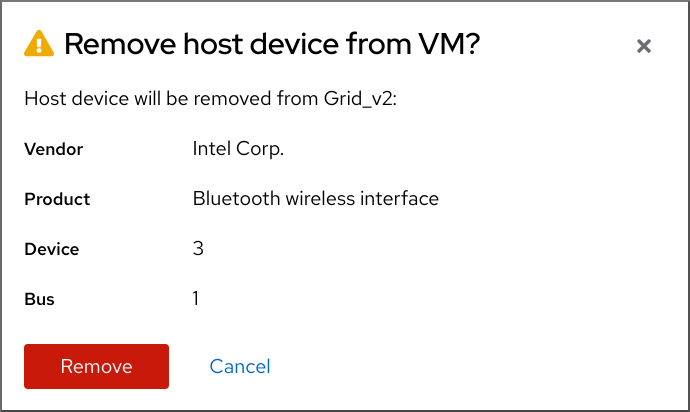

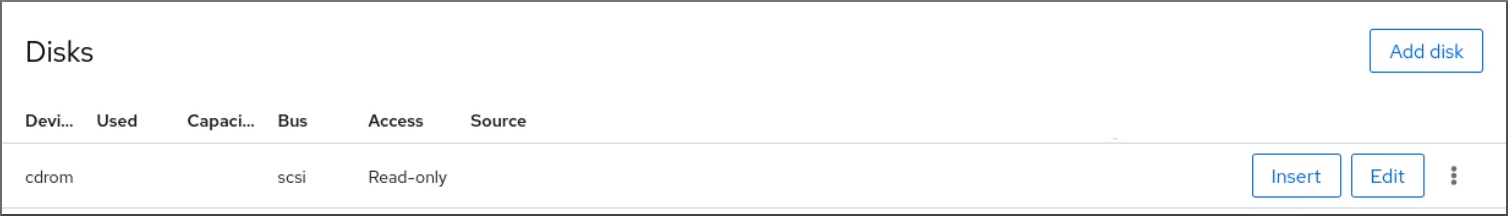

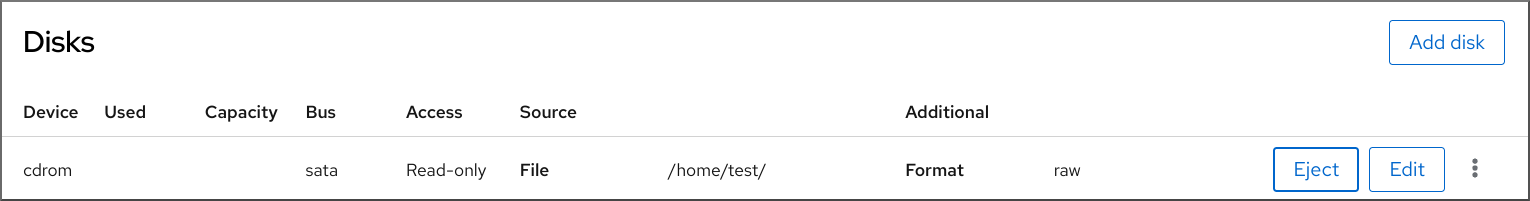

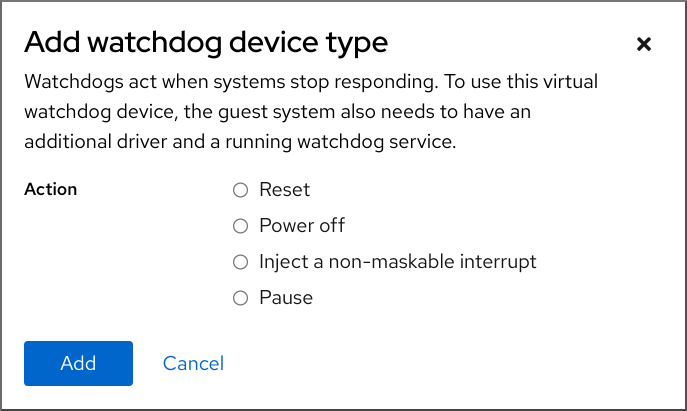

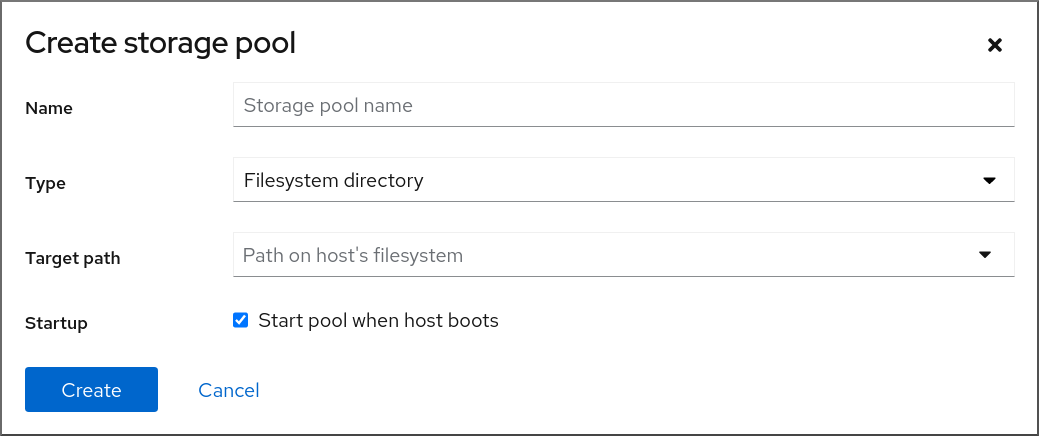

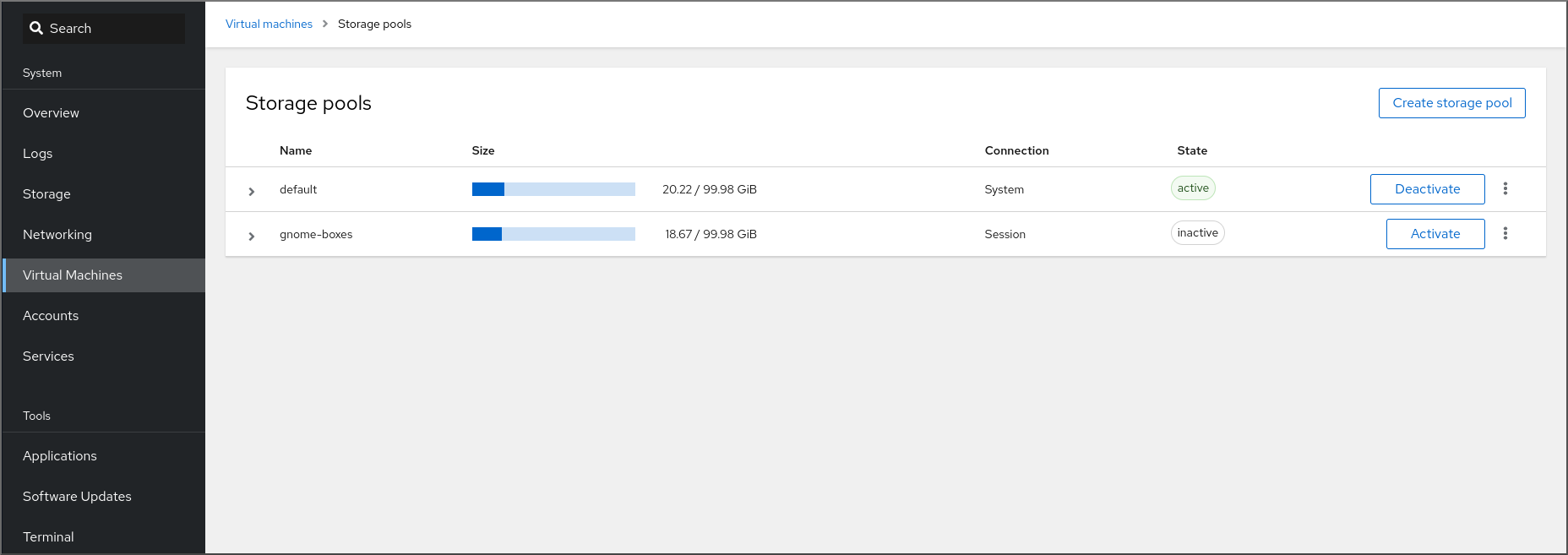

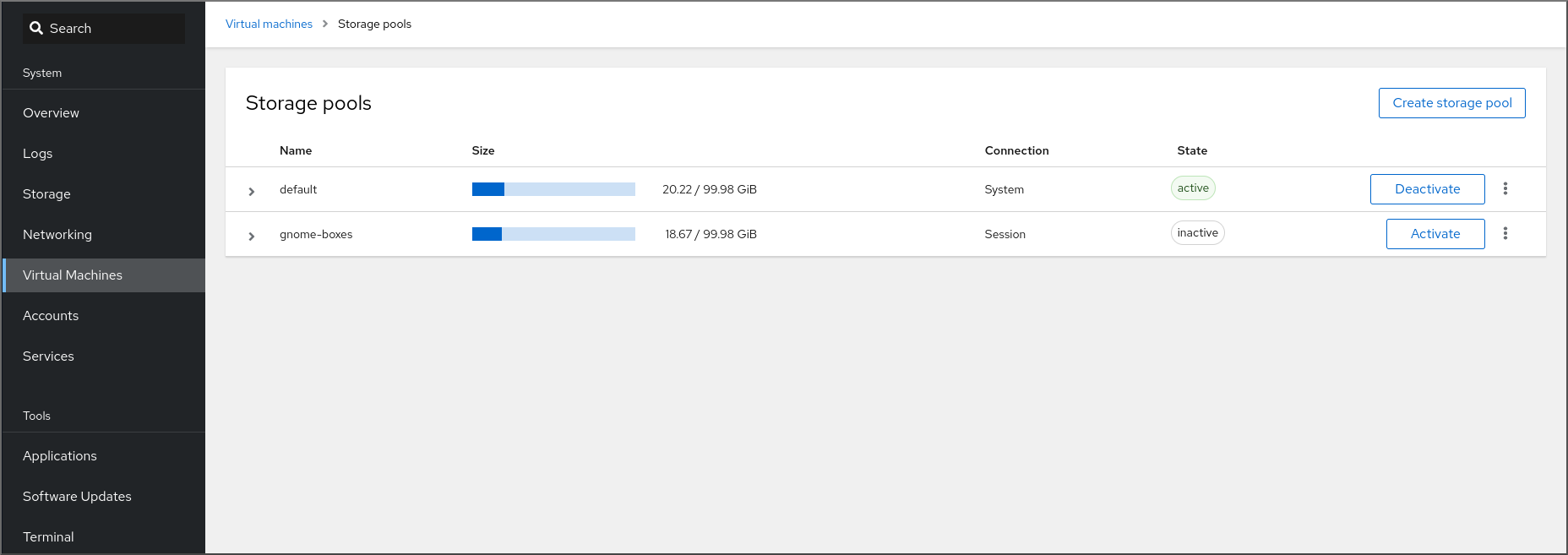

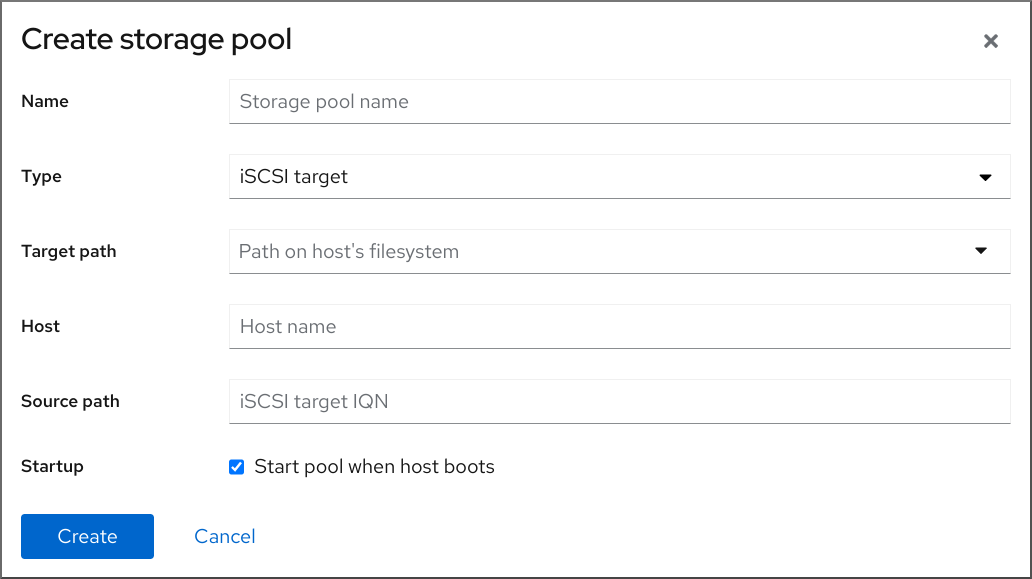

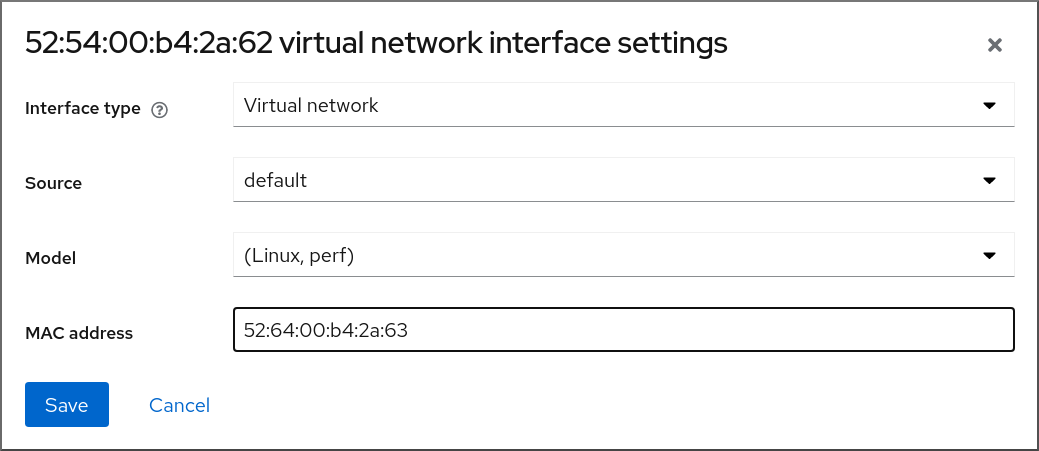

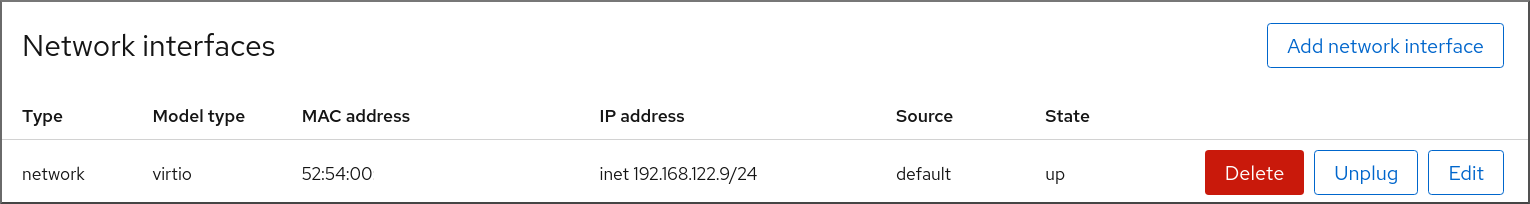

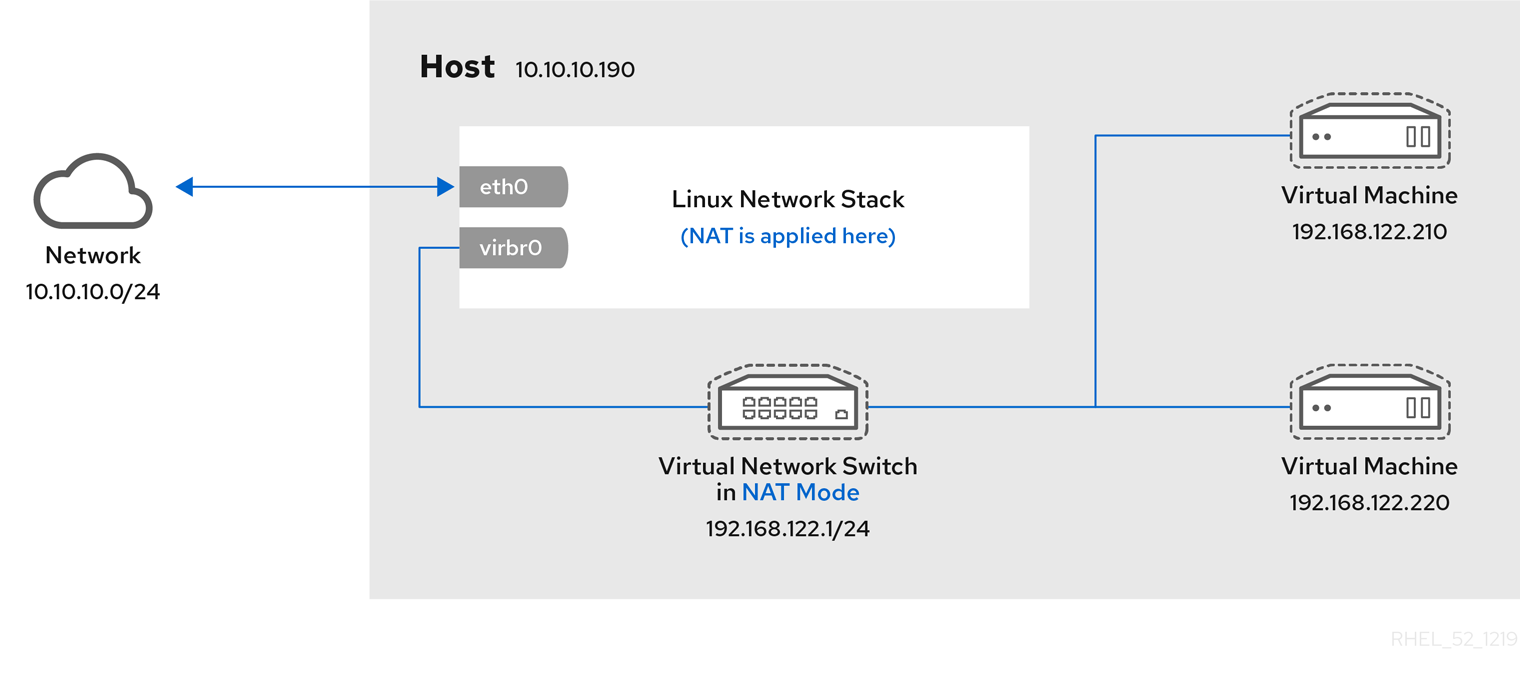

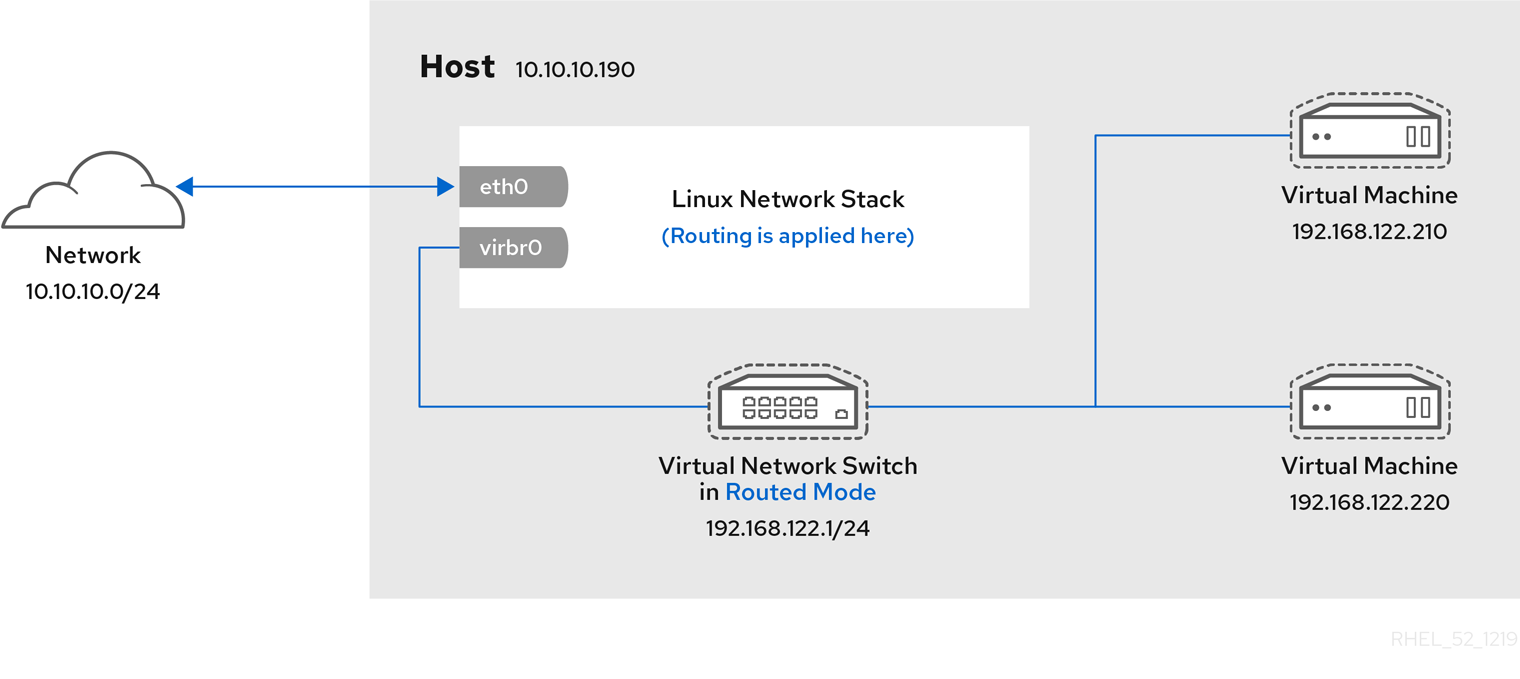

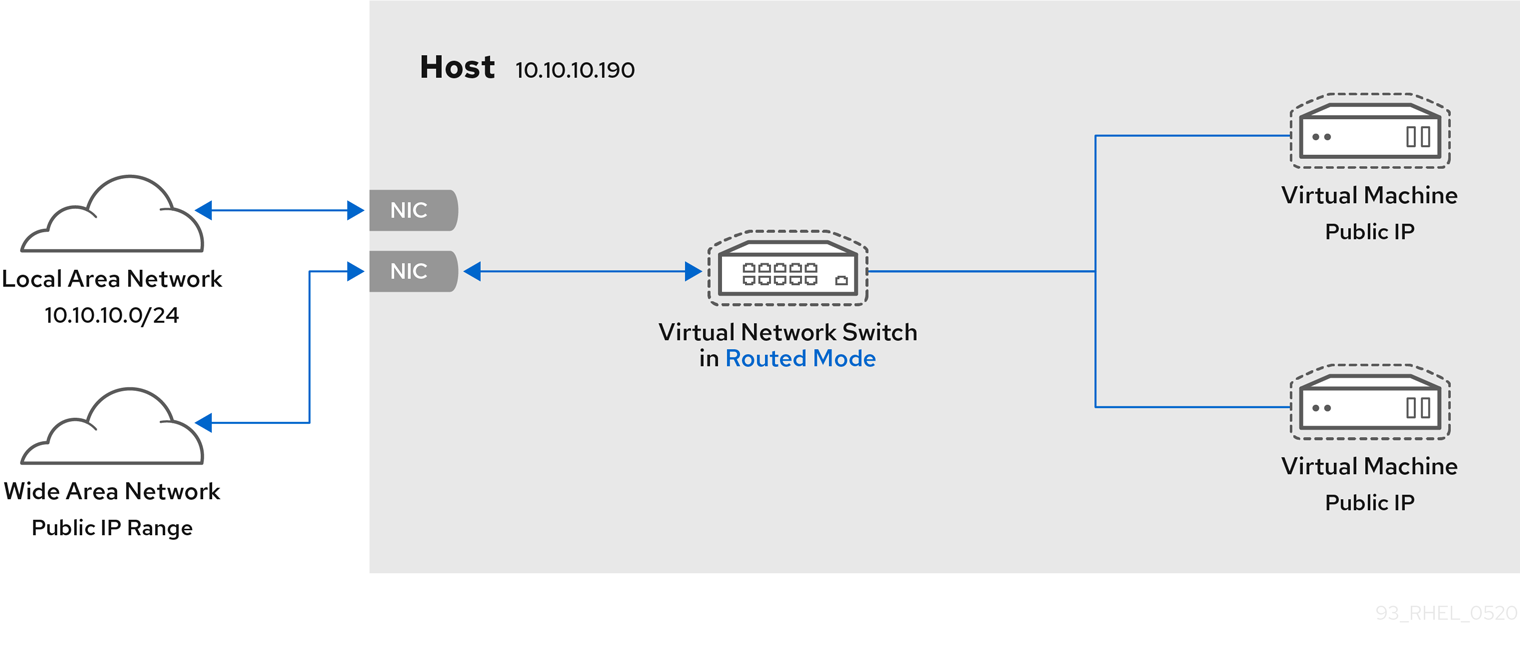

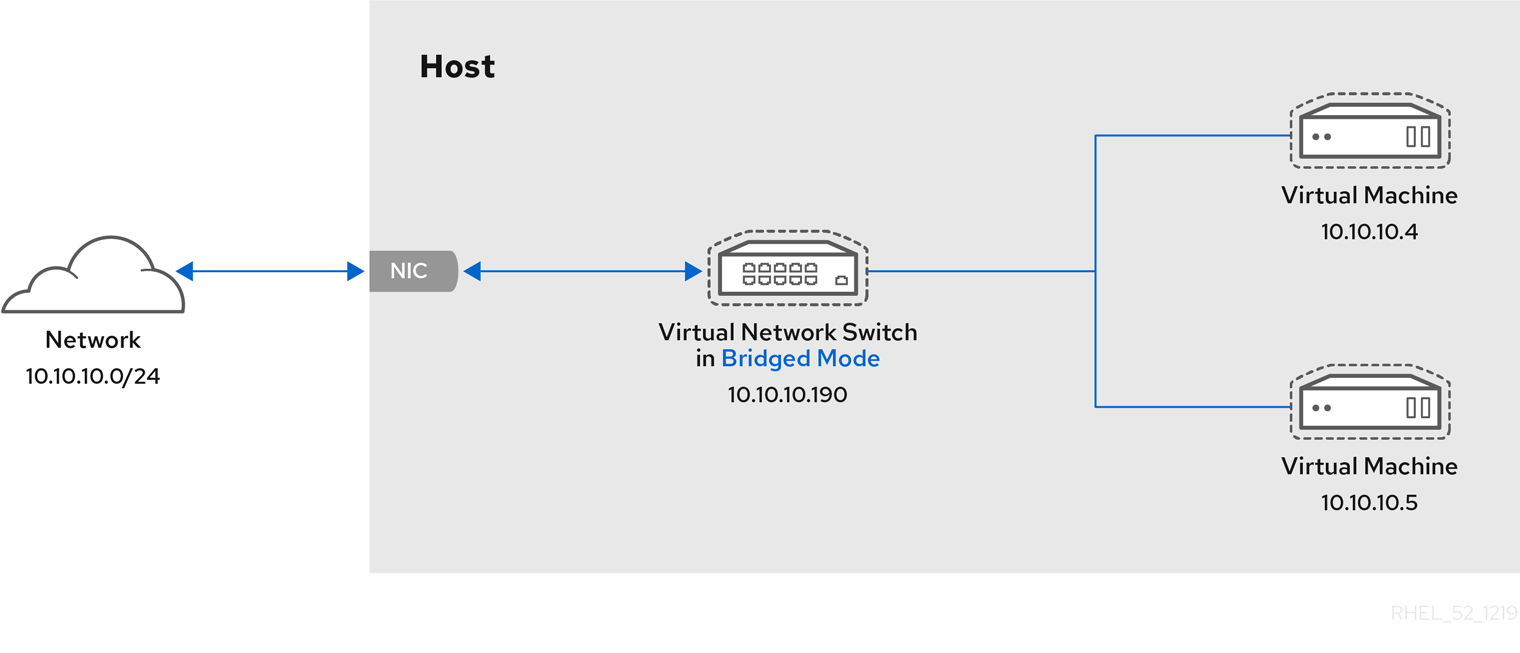

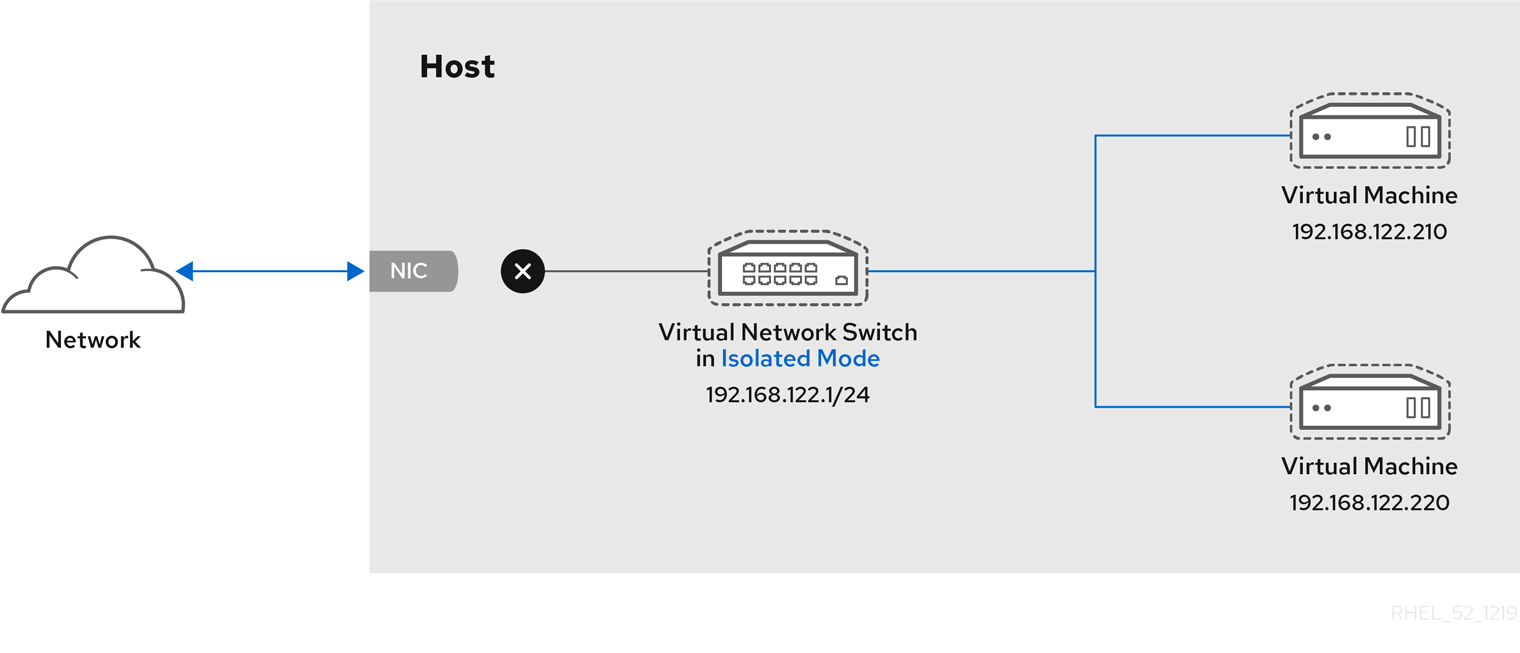

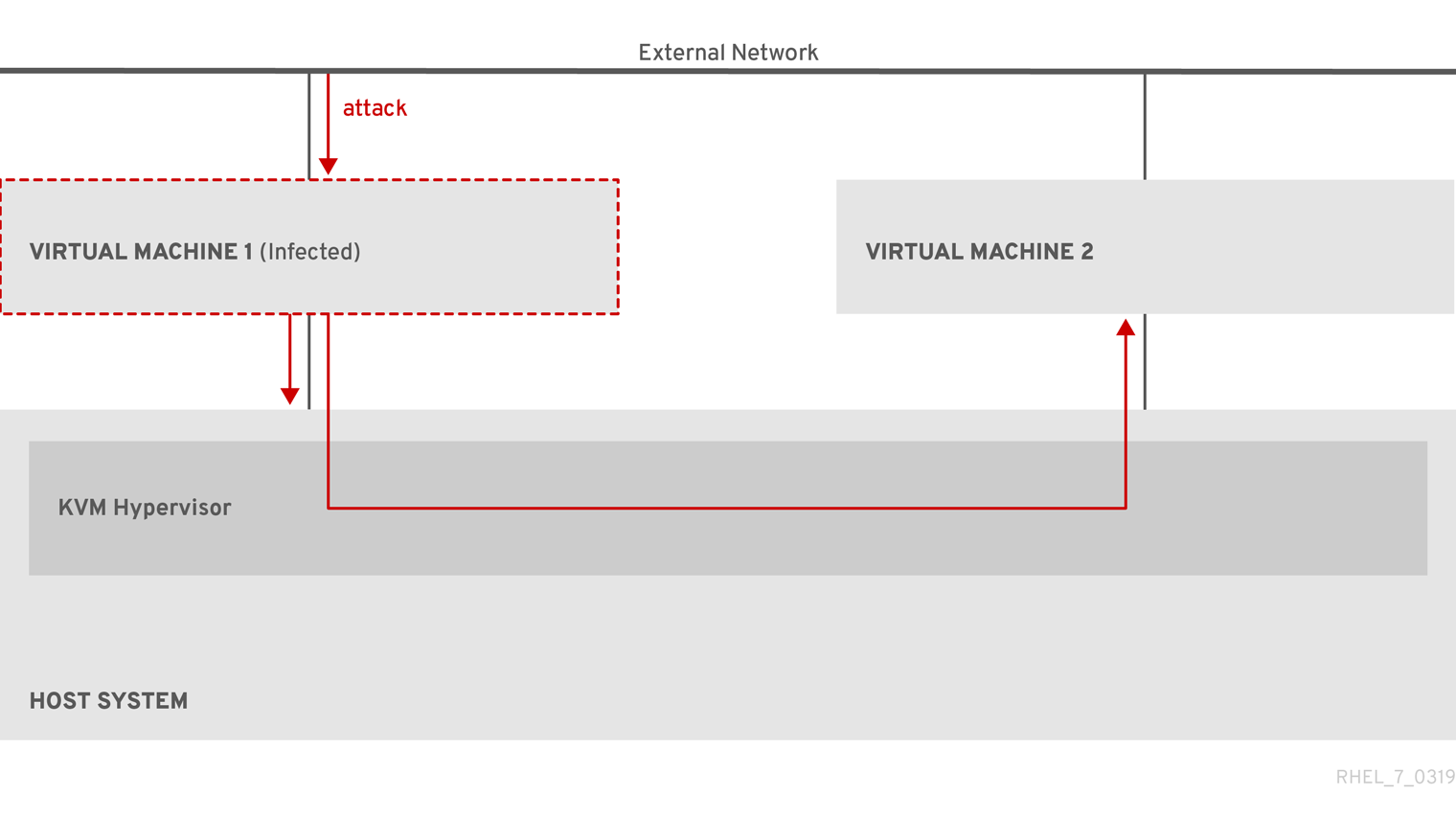

Procedure