開発者ガイド

OpenShift Container Platform 3.10 開発者リファレンス

概要

- Web コンソールを使用したプロジェクトのモニターおよび参照

- CLI の設定および利用

- テンプレートを使用した設定の生成

- ビルドおよび Webhook の管理

- デプロイメントの定義およびトリガー

- 外部サービス (データベース、SaaS エンドポイント) の統合

第1章 概要

本書はアプリケーション開発者を対象としており、OpenShift Container Platform クラウド環境でアプリケーションを開発し、デプロイするためにワークステーションをセットアップし、設定する方法について説明します。これには詳細の説明および例が含まれ、開発者が以下を実行するのに役立ちます。

第2章 アプリケーションライフサイクル管理

2.1. 開発プロセスの計画

2.1.1. 概要

OpenShift Container Platform はアプリケーションをビルドし、デプロイできるように設計されています。OpenShift Container Platform を開発プロセスにどの程度組み込むかに応じて、以下から選択できます。

- OpenShift Container Platform プロジェクト内での開発にフォーカスして、アプリケーションをゼロからビルドし、その後の継続的な開発とライフサイクルの管理を行うために OpenShift Container Platform を使用する。

- 別の環境ですでに開発したアプリケーション (例: バイナリー、コンテナーイメージ、ソースコード) を OpenShift Container Platform にデプロイする。

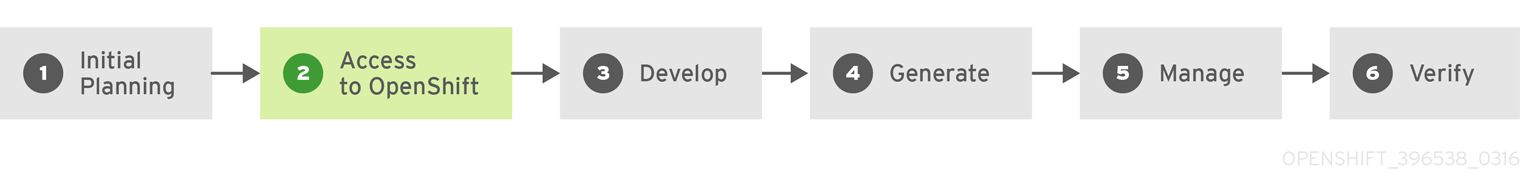

2.1.2. 開発環境としての OpenShift Container Platform の使用

OpenShift Container Platform を直接使用してアプリケーションの開発をゼロから行うことができます。この種類の開発プロセスを計画する場合には、以下の手順を考慮してください。

初期計画

- アプリケーションの機能は?

- どのプログラミング言語を使用して開発するか?

OpenShift Container Platform へのアクセス

- この時点で、ご自身または組織内の管理者が OpenShift Container Platform をインストールする必要があります。

開発

- 各自が選択するエディターまたは IDE を使用して、アプリケーションの基本的なスケルトンを作成します。このスケルトンは、OpenShift Container Platform が「アプリケーションの種類」について認識できるように適切に作成されている必要があります。

- コードを Git リポジトリーにプッシュします。

生成

-

oc new-appコマンドを使用して「基本的なアプリケーションを作成」します。OpenShift Container Platform はビルドおよびデプロイメント設定を生成します。

管理

- アプリケーションコードの開発を開始します。

- アプリケーションが正常にビルドされることを確認します。

- 引き続きコードをローカルで開発し、コードを改良します。

- コードを Git リポジトリーにプッシュします。

- 追加の設定が必要かどうかを確認します。追加のオプションについて『開発者ガイド』で確認してください。

検証

-

アプリケーションは数多くの方法で検証できます。変更をアプリケーションの Git リポジトリーにプッシュし、OpenShift Container Platform を使用してアプリケーションの再ビルドおよび再デプロイを行うことができます。または、

rsyncでホットデプロイを実行して、コードの変更を実行中の Pod で同期できます。

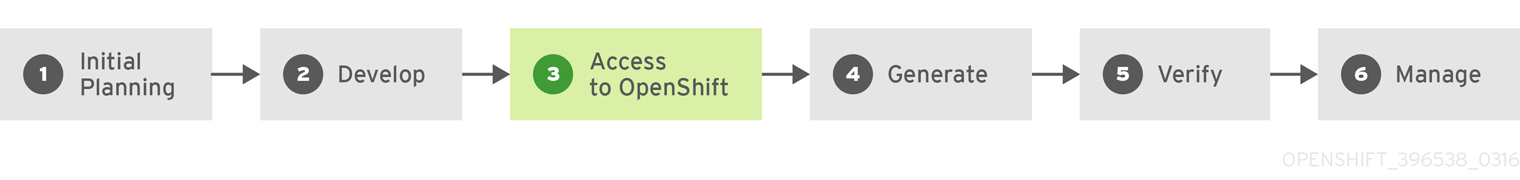

2.1.3. アプリケーションの OpenShift Container Platform へのデプロイ

アプリケーション開発ストラテジーの別の可能性として、ローカルで開発してから OpenShift Container Platform を使用して完全に開発されたアプリケーションをデプロイする方法があります。アプリケーションコードを先に準備してからビルドし、完了後に OpenShift Container Platform インストールにデプロイする場合は、以下の手順を使用します。

初期計画

- アプリケーションの機能は?

- どのプログラミング言語を使用して開発するか?

開発

- 任意のエディターまたは IDE を使用してアプリケーションコードを開発します。

- アプリケーションコードをローカルでビルドしてテストします。

- コードを Git リポジトリーにプッシュします。

OpenShift Container Platform へのアクセス

- この時点で、ご自身または組織内の管理者が OpenShift Container Platform をインストールする必要があります。

生成

-

oc new-appコマンドを使用して「基本的なアプリケーションを作成」します。OpenShift Container Platform はビルドおよびデプロイメント設定を生成します。

検証

- 前述の生成の手順においてビルドおよびデプロイしたアプリケーションが OpenShift Container Platform で正常に実行されていることを確認します。

管理

- 納得の行く結果が得られるまで、アプリケーションコードの開発を続けます。

- 新たにプッシュされたコードを受け入れるには、アプリケーションを OpenShift Container Platform で再ビルドします。

- 追加の設定が必要かどうかを確認します。追加のオプションについて『開発者ガイド』で確認してください。

2.2. 新規アプリケーションの作成

2.2.1. 概要

OpenShift CLI または web コンソールのいずれかを使用して、ソースまたはバイナリーコード、イメージおよびテンプレート (あるいは両方) を含むコンポーネントから新規の OpenShift Container Platform アプリケーションを作成できます。

2.2.2. CLI を使用したアプリケーションの作成

2.2.2.1. ソースコードからのアプリケーションの作成

new-app コマンドでは、ローカルまたはリモートの Git リポジトリーのソースコードからアプリケーションを作成できます。

ローカルディレクトリーの Git リポジトリーを使用してアプリケーションを作成するには、以下を実行します。

oc new-app /path/to/source/code

$ oc new-app /path/to/source/code

ローカルの Git リポジトリーを使用する場合には、OpenShift Container Platform クラスターがアクセス可能な URL を参照する origin という名前のリモートが必要です。認識されているリモートがない場合は、new-app により「バイナリービルド」が作成されます。

リモート Git リポジトリーを使用してアプリケーションを作成するには、以下を実行します。

oc new-app https://github.com/sclorg/cakephp-ex

$ oc new-app https://github.com/sclorg/cakephp-exプライベートのリモート Git リポジトリーを使用してアプリケーションを作成するには、以下を実行します。

oc new-app https://github.com/youruser/yourprivaterepo --source-secret=yoursecret

$ oc new-app https://github.com/youruser/yourprivaterepo --source-secret=yoursecret

プライベートのリモート Git リポジトリーを使用する場合には、--source-secret フラグを使用して、既存の「ソースクローンのシークレット」を指定できます。これは、BuildConfig に挿入され、リポジトリーにアクセスできるようになります。

--context-dir フラグを指定することで、ソースコードリポジトリーのサブディレクトリーを使用できます。リモート Git リポジトリーおよびコンテキストのサブディレクトリーを使用してアプリケーションを作成する場合は、以下を実行します。

oc new-app https://github.com/sclorg/s2i-ruby-container.git \

--context-dir=2.0/test/puma-test-app

$ oc new-app https://github.com/sclorg/s2i-ruby-container.git \

--context-dir=2.0/test/puma-test-app

また、リモートの URL を指定する場合には、以下のように URL の最後に #<branch_name> を追加することで、使用する Git ブランチを指定できます。

oc new-app https://github.com/openshift/ruby-hello-world.git#beta4

$ oc new-app https://github.com/openshift/ruby-hello-world.git#beta4

new-app コマンドは、「ビルド設定 (BuildConfig)」を作成し、これはソースコードから、新規のアプリケーション「イメージ」を作成します。new-app コマンドは通常、「デプロイメント設定 (DeploymentConfig)」を作成して新規のイメージをデプロイするほか、「サービス」を作成してイメージを実行するデプロイメントへの負荷分散したアクセスを提供します。

OpenShift Container Platform は Docker、Pipeline または Source「ビルドストラテジー」のいずれを使用すべきかを自動的に「検出」します。また、Source ビルドの場合は、「適切な言語のビルダーイメージを検出します」。

ビルドストラテジーの検出

新規アプリケーションの作成時に Jenkinsfile がソースリポジトリーの root または指定のコンテキストディレクトリーに存在する場合に、OpenShift Container Platform は「Pipeline ビルドストラテジー」を生成します。または、Dockerfile がある場合に、OpenShift Container Platform は 「Docker ビルドストラテジー」を生成します。Dockerfile がない場合には、「Source ビルドストラテジー」を生成します。

ビルドストラテジーを上書きするには、--strategy フラグを docker、pipeline または source のいずれかに設定してください。

oc new-app /home/user/code/myapp --strategy=docker

$ oc new-app /home/user/code/myapp --strategy=docker

oc コマンドを使用するには、ビルドのソースを含むファイルがリモートの git リポジトリーで利用できる必要があります。ソースの全ビルドには、git remote -v を使用する必要があります。

言語検出

Source ビルドストラテジーを使用する場合に、new-app はリポジトリーの root または指定したコンテキストディレクトリーに特定のファイルが存在するかどうかで、使用する言語ビルダーを判別しようとします。

| 言語 | ファイル |

|---|---|

|

|

project.json、*.csproj |

|

|

pom.xml |

|

|

app.json、package.json |

|

|

cpanfile、index.pl |

|

|

composer.json、index.php |

|

|

requirements.txt、setup.py |

|

|

Gemfile, Rakefile、config.ru |

|

|

build.sbt |

|

|

Godeps、main.go |

言語の検出後、new-app は、検出言語に一致する supports アノテーションが指定された 「イメージストリーム」タグか、または検出言語の名前に一致するイメージストリームがないかどうか、OpenShift Container Platform サーバーを検索します。一致するものが見つからない場合には、new-app は Docker Hub レジストリー で名前をベースにした検出言語と一致するイメージの検索を行います。

~ をセパレーターとして使用し、イメージ (イメージストリームまたはコンテナーの仕様) とリポジトリーを指定して、ビルダーが特定のソースリポジトリーを使用するようにイメージを上書きすることができます。この方法を使用すると、ビルドストラテジーの検出 および 言語の検出 は実行されない点に留意してください。

たとえば、リモートリポジトリーのソースを使用して myproject/my-ruby イメージストリームを作成する場合は、以下を実行します。

oc new-app myproject/my-ruby~https://github.com/openshift/ruby-hello-world.git

$ oc new-app myproject/my-ruby~https://github.com/openshift/ruby-hello-world.gitローカルリポジトリーのソースを使用して openshift/ruby-20-centos7:latest コンテナーのイメージストリームを作成するには、以下を実行します。

oc new-app openshift/ruby-20-centos7:latest~/home/user/code/my-ruby-app

$ oc new-app openshift/ruby-20-centos7:latest~/home/user/code/my-ruby-app2.2.2.2. イメージからアプリケーションを作成する方法

既存のイメージからアプリケーションのデプロイが可能です。イメージは、OpenShift Container Platform サーバー内のイメージストリーム、指定したレジストリー内またはDocker Hub レジストリー 内のイメージ、またはローカルの Docker サーバー内のイメージから取得できます。

new-app コマンドは、渡された引数に指定されたイメージの種類を判断しようとしますが、イメージが Docker イメージ (--docker-image の引数を使用) なのか、またはイメージストリーム (-i|--image の引数を使用) なのか、new-app に明示できます。

ローカル Docker リポジトリーからイメージを指定した場合、同じイメージが OpenShift Container Platform のクラスターノードでも利用できることを確認する必要があります。

たとえば、DockerHub MySQL イメージからアプリケーションを作成するには、以下を実行します。

oc new-app mysql

$ oc new-app mysqlプライベートのレジストリーのイメージを使用してアプリケーションを作成する場合には、Docker イメージの仕様全体を以下のように指定します。

oc new-app myregistry:5000/example/myimage

$ oc new-app myregistry:5000/example/myimage

イメージを含むレジストリーが「SSL でセキュリティー保護」されていない場合には、OpenShift Container Platform ノードホストの Docker デーモンが、対象のレジストリーを参照する --insecure-registry フラグを指定して実行されていることを、クラスター管理者は確認する必要があります。また、--insecure-registry フラグを指定して、セキュアでないレジストリーからイメージを取得していることを、new-app に示す必要があります。

以下のように、既存の「イメージストリーム」および任意の「イメージストリームタグ」からアプリケーションを作成することができます。

oc new-app my-stream:v1

$ oc new-app my-stream:v12.2.2.3. テンプレートからのアプリケーションの作成

テンプレート名を引数として指定して、事前に保存した「テンプレート」またはテンプレートファイルからアプリケーションを作成することができます。たとえば、サンプルアプリケーションテンプレート を保存し、これを利用してアプリケーションを作成できます。

保存したテンプレートからアプリケーションを作成する場合、以下を実行します。

oc create -f examples/sample-app/application-template-stibuild.json oc new-app ruby-helloworld-sample

$ oc create -f examples/sample-app/application-template-stibuild.json

$ oc new-app ruby-helloworld-sample

事前に OpenShift Container Platform に保存することなく、ローカルファイルシステムでテンプレートを直接使用するには、以下の -f|--file 引数を使用します。

oc new-app -f examples/sample-app/application-template-stibuild.json

$ oc new-app -f examples/sample-app/application-template-stibuild.jsonテンプレートパラメーター

「テンプレート」をベースとするアプリケーションを作成する場合には、以下の -p|--param 引数を使用してテンプレートで定義したパラメーター値を設定します。

oc new-app ruby-helloworld-sample \

-p ADMIN_USERNAME=admin -p ADMIN_PASSWORD=mypassword

$ oc new-app ruby-helloworld-sample \

-p ADMIN_USERNAME=admin -p ADMIN_PASSWORD=mypassword

パラメーターをファイルに保存しておいて、--param-file を指定して、テンプレートをインスタンス化する時にこのファイルを使用することができます。標準入力からパラメーターを読み込む場合は、以下のように--param-file=- を使用します。

cat helloworld.params ADMIN_USERNAME=admin ADMIN_PASSWORD=mypassword $ oc new-app ruby-helloworld-sample --param-file=helloworld.params $ cat helloworld.params | oc new-app ruby-helloworld-sample --param-file=-

$ cat helloworld.params

ADMIN_USERNAME=admin

ADMIN_PASSWORD=mypassword

$ oc new-app ruby-helloworld-sample --param-file=helloworld.params

$ cat helloworld.params | oc new-app ruby-helloworld-sample --param-file=-2.2.2.4. アプリケーション作成における追加修正

new-app コマンドは、OpenShift Container Platform オブジェクトを生成します。このオブジェクトにより、作成されるアプリケーションがビルドされ、デプロイされ、実行されます。通常、これらのオブジェクトはインプットソースリポジトリーまたはインプットされたイメージに由来する名前を使用して現在のプロジェクトに作成されますが、new-app によりこの動作を修正することができます。

new-app で作成したオブジェクトのセットは、ソースリポジトリー、イメージまたはテンプレートなどのインプットとして渡されるアーティファクトによって異なります。

| オブジェクト | 説明 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

その他 |

テンプレート のインスタンスを作成する際に、他のオブジェクトがテンプレートに基づいて生成される可能性があります。 |

2.2.2.4.1. 環境変数の指定

テンプレート、ソース または イメージ からアプリケーションを生成する場合、-e|--env 引数を使用し、ランタイムに環境変数をアプリケーションコンテナーに渡すことができます。

oc new-app openshift/postgresql-92-centos7 \

-e POSTGRESQL_USER=user \

-e POSTGRESQL_DATABASE=db \

-e POSTGRESQL_PASSWORD=password

$ oc new-app openshift/postgresql-92-centos7 \

-e POSTGRESQL_USER=user \

-e POSTGRESQL_DATABASE=db \

-e POSTGRESQL_PASSWORD=password

変数は、--env-file 引数を使用してファイルから読み取ることもできます。

cat postgresql.env POSTGRESQL_USER=user POSTGRESQL_DATABASE=db POSTGRESQL_PASSWORD=password $ oc new-app openshift/postgresql-92-centos7 --env-file=postgresql.env

$ cat postgresql.env

POSTGRESQL_USER=user

POSTGRESQL_DATABASE=db

POSTGRESQL_PASSWORD=password

$ oc new-app openshift/postgresql-92-centos7 --env-file=postgresql.env

さらに --env-file=- を使用することで、標準入力で環境変数を指定することもできます。

cat postgresql.env | oc new-app openshift/postgresql-92-centos7 --env-file=-

$ cat postgresql.env | oc new-app openshift/postgresql-92-centos7 --env-file=-詳細については、「環境変数の管理」を参照してください。

-e|--env または --env-file 引数で渡される環境変数では、new-app 処理の一環として作成される BuildConfig オブジェクトは更新されません。

2.2.2.4.2. ビルド環境変数の指定

テンプレート、ソース または イメージ からアプリケーションを生成する場合、--build-env 引数を使用し、ランタイムに環境変数をビルドコンテナーに渡すことができます。

oc new-app openshift/ruby-23-centos7 \

--build-env HTTP_PROXY=http://myproxy.net:1337/ \

--build-env GEM_HOME=~/.gem

$ oc new-app openshift/ruby-23-centos7 \

--build-env HTTP_PROXY=http://myproxy.net:1337/ \

--build-env GEM_HOME=~/.gem

変数は、--build-env-file 引数を使用してファイルから読み取ることもできます。

cat ruby.env HTTP_PROXY=http://myproxy.net:1337/ GEM_HOME=~/.gem $ oc new-app openshift/ruby-23-centos7 --build-env-file=ruby.env

$ cat ruby.env

HTTP_PROXY=http://myproxy.net:1337/

GEM_HOME=~/.gem

$ oc new-app openshift/ruby-23-centos7 --build-env-file=ruby.env

さらに --build-env-file=- を使用して、環境変数を標準入力で指定することもできます。

cat ruby.env | oc new-app openshift/ruby-23-centos7 --build-env-file=-

$ cat ruby.env | oc new-app openshift/ruby-23-centos7 --build-env-file=-2.2.2.4.3. ラベルの指定

ソース、イメージ または テンプレート からアプリケーションを生成する場合、-l|--label 引数を使用し、作成されたオブジェクトにラベルを追加できます。ラベルを使用すると、アプリケーションに関連するオブジェクトを一括で選択、設定、削除することが簡単になります。

oc new-app https://github.com/openshift/ruby-hello-world -l name=hello-world

$ oc new-app https://github.com/openshift/ruby-hello-world -l name=hello-world2.2.2.4.4. 作成前の出力の表示

new-app が作成する内容についてのドライランを確認するには、yaml または json の値と共に -o|--output 引数を使用できます。次にこの出力を使用して、作成されるオブジェクトのプレビューまたは編集可能なファイルへのリダイレクトを実行できます。問題がなければ、oc create を使用して OpenShift Container Platform オブジェクトを作成できます。

new-app アーティファクトをファイルに出力するには、これらを編集し、作成します。

oc new-app https://github.com/openshift/ruby-hello-world \

-o yaml > myapp.yaml

vi myapp.yaml

oc create -f myapp.yaml

$ oc new-app https://github.com/openshift/ruby-hello-world \

-o yaml > myapp.yaml

$ vi myapp.yaml

$ oc create -f myapp.yaml2.2.2.4.5. 別名でのオブジェクトの作成

通常 new-app で作成されるオブジェクトの名前はソースリポジトリーまたは生成に使用されたイメージに基づいて付けられます。コマンドに --name フラグを追加することで、生成されたオブジェクトの名前を設定できます。

oc new-app https://github.com/openshift/ruby-hello-world --name=myapp

$ oc new-app https://github.com/openshift/ruby-hello-world --name=myapp2.2.2.4.6. 別のプロジェクトでのオブジェクトの作成

通常 new-app は現在のプロジェクトにオブジェクトを作成しますが、-n|--namespace 引数を使用してアクセス可能な別のプロジェクトにオブジェクトを作成することができます。

oc new-app https://github.com/openshift/ruby-hello-world -n myproject

$ oc new-app https://github.com/openshift/ruby-hello-world -n myproject2.2.2.4.7. 複数のオブジェクトの作成

new-app コマンドは、複数のパラメーターを new-app に指定して複数のアプリケーションを作成できます。コマンドラインで指定するラベルは、この単一コマンドで作成されるすべてのオブジェクトに適用され、環境変数はソースまたはイメージから作成されるすべてのコンポーネントに適用されます。

ソースリポジトリーおよび Docker Hub イメージからアプリケーションを作成するには、以下を実行します。

oc new-app https://github.com/openshift/ruby-hello-world mysql

$ oc new-app https://github.com/openshift/ruby-hello-world mysql

ソースコードリポジトリーおよびビルダーイメージが別個の引数として指定されている場合、new-app はソースコードリポジトリーのビルダーとしてそのビルダーイメージを使用します。これを意図していない場合は、~ セパレーターを使用してソースに必要なビルダーイメージを指定します。

2.2.2.4.8. 単一 Pod でのイメージとソースのグループ化

new-app コマンドにより、単一 Pod に複数のイメージをまとめてデプロイできます。イメージのグループ化を指定するには + セパレーターを使用します。--group コマンドライン引数をグループ化する必要のあるイメージを指定する際に使用することもできます。ソースリポジトリーからビルドされたイメージを別のイメージと共にグループ化するには、そのビルダーイメージをグループで指定します。

oc new-app ruby+mysql

$ oc new-app ruby+mysqlソースからビルドされたイメージと外部のイメージをまとめてデプロイするには、以下を実行します。

oc new-app \

ruby~https://github.com/openshift/ruby-hello-world \

mysql \

--group=ruby+mysql

$ oc new-app \

ruby~https://github.com/openshift/ruby-hello-world \

mysql \

--group=ruby+mysql2.2.2.4.9. イメージ、テンプレート、および他の入力の検索

イメージ、テンプレート、および oc new-app コマンドの他の入力内容を検索するには、--search フラグおよび --list フラグを追加します。たとえば、PHP を含むすべてのイメージまたはテンプレートを検索するには、以下を実行します。

oc new-app --search php

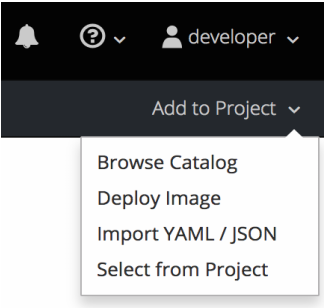

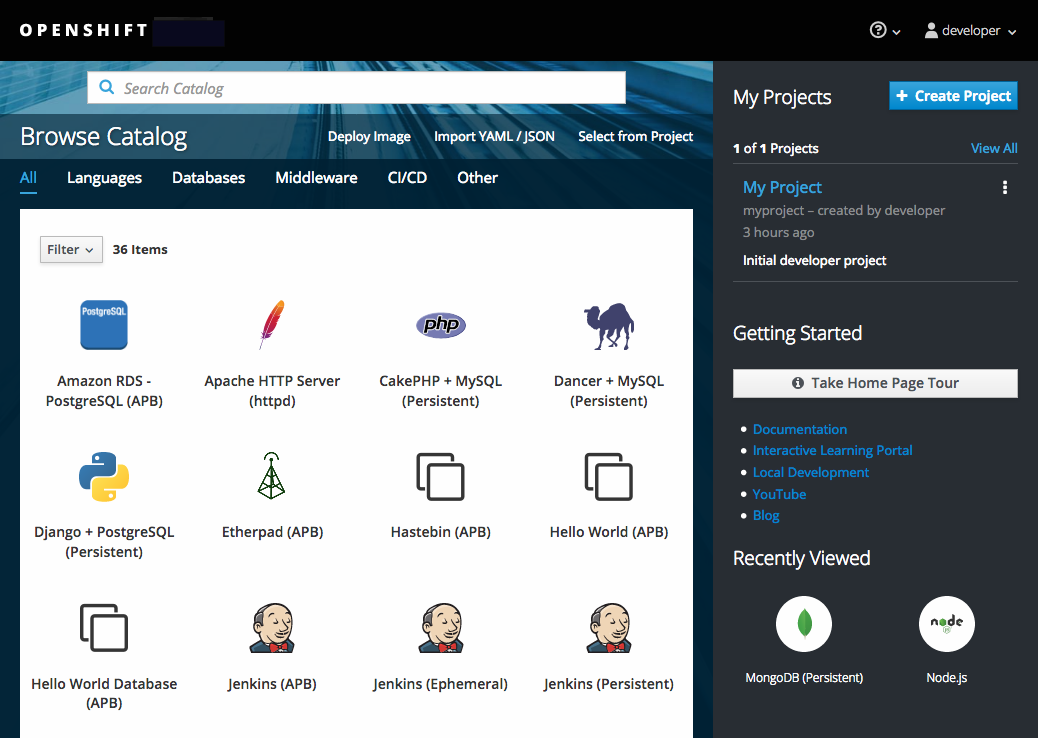

$ oc new-app --search php2.2.3. Web コンソールを使用したアプリケーションの作成

必要なプロジェクトで Add to Project をクリックします。

プロジェクト内にあるイメージの一覧またはサービスカタログからビルダーイメージを選択します。

注記

注記以下に示すように、builder タグがアノテーションに一覧表示されている 「イメージストリームタグ」のみが一覧に表示されます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ここに builder タグを含めると、この

ImageStreamTagがビルダーとして Web コンソールに表示されます。

新規アプリケーション画面で設定を変更し、オブジェクトをアプリケーションをサポートするように設定します。

2.3. 環境全体におけるアプリケーションのプロモート

2.3.1. 概要

アプリケーションのプロモーションとは、さまざまなランタイム環境でのアプリケーションの移動を意味します。通常は、移動により成熟度が向上していきます。たとえば、あるアプリケーションが開発環境からスタートし、ステージング環境へと進み、さらなるテストが行われ、最後に実稼働環境へとプロモートされる場合に、アプリケーションに変更が加えられると、変更が開発環境に加えられ、ステージング環境および実稼働環境へとプロモートされます。

「アプリケーション」は、単に Java、Perl、および Python などで記述された単なるソースコードを意味する訳でも、静的 Web コンテンツや統合スクリプト、またはアプリケーションの言語固有のランタイムに関連する設定に留まる訳でもありません。現在のアプリケーションは、これらの言語固有のランタイムで使用されるアプリケーション固有のアーカイブ以上のものを指します。

OpenShift Container Platform および Kubernetes と Docker を統合した基盤という環境では、追加のアプリケーションのアーティファクトとして以下が含まれます。

- メタデータと関連ツールの豊富なセットを含む Docker コンテナーイメージ 。

- アプリケーションで使用されるためにコンテナーに挿入される 環境変数。

以下の OpenShift Container Platform の API オブジェクト (リソース定義としても知られています。「コアとなる概念」を参照してください)。

- アプリケーションで使用されるためにコンテナーに挿入される API オブジェクト。

- OpenShift Container Platform によるコンテナーおよび Pod の管理方法を指示する API オブジェクト。

OpenShift Container Platform でのアプリケーションのプロモート方法を検討するため、本トピックでは以下を扱います。

- アプリケーション定義に導入される新規アーティファクトの詳細。

- アプリケーションのプロモーションパイプラインの各種環境を区別する方法。

- 新規アーティファクトを管理する方法およびツールについて。

- 各種の概念、構成、方法およびツールをアプリケーションのプロモートに適用する実例。

2.3.2. アプリケーションコンポーネント

2.3.2.1. API オブジェクト

OpenShift Container Platform および Kubernetes リソース定義 (アプリケーションインベントリーに新規に導入された項目) に関連して、アプリケーションのプロモートについて検討する際に API オブジェクトの設計ポイントについて留意しておくべき 2 つの主要な点があります。

1 つ目の点として、すべての API オブジェクトは、OpenShift Container Platform ドキュメント全体で強調されているように JSON または YAML のいずれかで表現することができます。そのため、これらのリソース定義は従来のソースコントロールおよびスクリプトを使用して容易に管理できます。

2 つ目の点として、API オブジェクトは、システムの必要とされる状態を指定するオブジェクトの部分とシステムのステータスまたは現在の状態を反映する部分で構成されるように設計されています。これはインプットおよびアウトプットとして捉えることができます。インプット部分は JSON または YAML で表現され、ソースコントロール管理 (SCM) のアーティファクトとして適合します。

API オブジェクトのインプット部分つまり仕様部分は、インスタンス化の際に テンプレート処理による変数置換を実行できるため、完全に静的または動的に機能する点に留意してください。

API オブジェクトに関する上記の点により、JSON または YAML ファイルの表現を使ってアプリケーションの設定をコードとして処理することができます。

ほぼすべての API オブジェクトについて、組織はこれらをアプリケーションのアーティファクトとみなすことができます。以下は、アプリケーションのデプロイおよび管理に最も関連するオブジェクトです。

- BuildConfigs

-

これはアプリケーションのプロモーションのコンテキストにおける特殊なリソースです。

BuildConfigはとくに開発者の観点ではアプリケーションの一部ではありますが、BuildConfigは通常パイプラインでプロモートされません。これはパイプラインで (他のアイテムと共に) プロモートされるイメージを作成します。 - Templates (テンプレート)

-

アプリケーションのプロモーションの観点では、

Templatesはとくにパラメーター化機能を使ってリソースを所定のステージング環境でセットアップするための開始ポイントとしての役割を果たします。ただしアプリケーションがプロモーションのパイプラインを移動する際に、インスタンス化の後に追加の変更が生じる可能性が高くなります。詳細については、シナリオおよび実例 を参照してください。 - Routes (ルート)

-

Route (ルート) は最も典型的なリソースで、アプリケーションプロモーションパイプラインのステージごとに異なります。アプリケーションの各種ステージに対するテストの際に、アプリケーションへのアクセスが

Route経由で行われるためです。また、ホスト名だけでなくRouteの HTTP レベルのセキュリティーに関しても、手動指定や自動生成のオプションがある点に留意してください。 - Services (サービス)

-

(初期ステージでの個々の開発者の便宜を考慮する場合など) 所定のアプリケーションプロモーションステージで

RoutersおよびRoutesを避ける理由がある場合、アプリケーションはClusterの IP アドレスおよびポート経由でアクセスできます。これらを使用した場合、ステージ間のアドレスおよびポートの管理の一部が必要となる可能性があります。 - Endpoints (エンドポイント)

-

特定のアプリケーションレベルのサービス (たとえば、多くの企業におけるデータベースのインスタンスなど) は OpenShift Container Platform で管理されない場合があります。そのような場合に、独自に

Endpointsを作成して、関連するService(Serviceのセレクターフィールドは除外) に必要な修正を加えると、(環境をどのようにプランニングするかにより異なりますが) アクティビティーがステージ間で重複または共有されます。 - シークレット

-

Secretsでカプセル化された機密情報は、その情報関連の対応するエンティティー (OpenShift Container Platform が管理するServiceまたは OpenShift Container Platform 外で管理する外部サービス) が共有されると、ステージ環境間で共有されます。このエンティティーの異なるバージョンがアプリケーションのプロモートパイプラインの各ステージにある場合には、パイプラインの各ステージで固有のSecretを維持するか、それをパイプラインの移動時に変更する必要がある場合があります。またSecretを SCM に JSON または YAML として保存する場合、機密情報を保護するための暗号化フォームが必要となることがあるので注意してください。 - DeploymentConfigs

- このオブジェクトは、所定のアプリケーションのプロモーションパイプラインステージの環境を定義し、そのスコープを設定する際の最も重要なリソースになります。これはアプリケーションの起動方法を管理します。各種ステージ間で共通する部分がありますが、アプリケーションプロモーションパイプラインの移動に伴い、このオブジェクトには変更が加えられます。この変更には、各ステージの環境の違いを反映させるための修正や、アプリケーションがサポートする必要のある各種シナリオのテストを容易にするためのシステム動作を変更が含まれます。

- ImageStreams, ImageStreamTags、および ImageStreamImage

- 「イメージ」および「イメージストリーム」の各セクションで説明されているように、これらのオブジェクトは、コンテナーイメージの管理に関連して OpenShift Container Platform の追加要素の中核を成しています。

- ServiceAccounts および RoleBindings

-

アプリケーション管理において、OpenShift Container Platform や外部サービスでの他の API オブジェクトに対するパーミッション管理は必要不可欠です。

Secretsと同様に、ServiceAccountsおよびRoleBindingscanオブジェクトのアプリケーションプロモーションパイプラインのステージ間での共有方法は、各種の異なる環境を共有するか、分離するかなどの各自のニーズによって異なります。 - PersistentVolumeClaims

- データベースのようなステートフルなサービスに関連して、これらが異なるアプリケーションプロモーションステージ間で共有される程度は、組織がアプリケーションデータのコピーを共有または隔離する方法に直接関連します。

- ConfigMap

-

Pod設定のPod自体からの分離 (環境変数スタイルの設定など) に関連して、これらはPodの動作に一貫性をもたせる場合に各種のステージング環境で共有することができます。またこれらをステージごとに変更してPod動作を変更することも可能です ( 通常アプリケーションの各種の側面はステージごとに検証されます)。

2.3.2.2. イメージ

前述のように、コンテナーイメージはアプリケーションのアーティファクトであり、実際に、アプリケーションのプロモーションにおいて、イメージおよびイメージの管理は新しいアプリケーションのアーティファクトの中でも重要な部分です。場合によっては、イメージはアプリケーション全体をカプセル化する場合もあり、アプリケーションのプロモーションフローはイメージの管理のみで成り立っています。

通常イメージは SCM システムでは管理されません (アプリケーションのバイナリーが以前のシステムで管理されていなかったのと同様です)。ただしバイナリーと同様に、インストール可能なアーティファクトおよび対応するリポジトリー (RPM、RPM リポジトリー、Nexus など) は SCM と同様のセマンティクスで生成されるので、SCM に似たイメージ管理の構成および専門用語が導入されました。

- Image registry == SCM server

- Image repository == SCM repository

イメージはレジストリーに存在するので、アプリケーションプロモーションでは、適切なイメージがレジストリーに存在し、そのイメージで表されるアプリケーションを実行する必要のある環境からアクセスできるようにします。

イメージを直接参照するよりも、アプリケーションの定義は通常イメージストリームに参照を抽象化します。これは、イメージストリームがアプリケーションコンポーネントを構成する別の API オブジェクトになることを意味します。イメージストリームについての詳細は、「中核となる概念」を参照してください。

2.3.2.3. 概要

これまでノート、イメージ、および API オブジェクトのアプリケーションのアーティファクトについて OpenShift Container Platform 内のアプリケーションプロモーションのコンテキストで説明しました。次は、アプリケーションをプロモーションパイプラインの各種ステージの どこで 実行するのかを見ていきます。

2.3.3. デプロイメント環境

このコンテキストでのデプロイメント環境は、CI/CD パイプラインの特定ステージでアプリケーションが実行される固有のスペースを表します。通常の環境には、「開発」、「テスト」、「ステージング」および「実稼働環境」などが含まれます。環境の境界については、以下のようにさまざまな方法で定義できます。

- 単一プロジェクト内のラベルおよび独自の名前を使用する

- クラスター内の固有のプロジェクトを使用する

- 固有のクラスターを使用する

上記の 3 つ方法すべてを利用できることが想定されます。

2.3.3.1. 留意事項

通常デプロイメント環境の構成を検討する際は、以下のヒューリスティックな側面について検討します。

- プロモーションフローの各種ステージで許可するリソース共有の度合い

- プロモーションフローの各種ステージで必要な分離の度合い

- プロモーションフローの各種ステージの中心からの位置 (またはどの程度地理的に分散しているか)

さらに OpenShift Container Platform のクラスターおよびプロジェクトがイメージレジストリーにどのように関係するかについて以下の重要な点に留意してください。

- 同一クラスター内の複数のプロジェクトは同一のイメージストリームにアクセスできる。

- 複数のクラスターが同一の外部レジストリーにアクセスできる。

- OpenShift Container Platform の内部イメージレジストリーがルート経由で公開される場合、クラスターはレジストリーのみを共有できる。

2.3.3.2. 概要

デプロイメント環境が定義された後、パイプライン内のステージの記述を含むプロモーションフローを実装できます。以下では、これらのプロモーションフローの実装を構成する方法およびツールについて説明します。

2.3.4. 方法およびツール

基本的にアプリケーションのプロモートとは、前述のアプリケーションのコンポーネントをある環境から別の環境に移動するプロセスのことです。アプリケーションのプロモートの自動化に関する全体的なソリューションを検討する前に、各種コンポーネントを手動で移動する場合に使用できるツールの概要について以下のサブセクションで見ていきましょう。

ビルドおよびデプロイメントの両方のプロセスにおいて多数の挿入ポイントを利用できます。これらは BuildConfig および DeploymentConfig API オブジェクトで定義されます。これらの hook により、データベースなどのデプロイされたコンポーネントおよび OpenShift Container Platform クラスター自体と対話できるカスタムスクリプトの呼び出しが可能となります。

したがって、hook 内からイメージタグ操作を実行するなど、このような hook を使用して、アプリケーションを環境間で効果的に移動するコンポーネント管理操作を実行できます。ただし、これらの hook ポイントの使用は、環境間でアプリケーションコンポーネントを移動する場合よりも、所定の環境でアプリケーションのライフサイクル管理を行う場合に適しています (アプリケーションの新バージョンがデプロイされる際のデータベーススキーマの移行に使用するなど)。

2.3.4.1. API オブジェクトの管理

1 つの環境で定義されるリソースは、新しい環境へのインポートに備えて JSON または YAML ファイルの内容としてエクスポートされます。したがって JSON または YAML としての API オブジェクトの表現は、アプリケーションパイプラインで API オブジェクトをプロモートする際の作業単位として機能します。このコンテンツのエクスポートやインポートには oc CLI を使用します。

OpenShift Container Platform のプロモーションフローには必要ないですが、JSON または YAML はファイルに保存されるので、SCM システムを使用したコンテンツの保存や取得について検討することができます。これにより、ブランチの作成、バージョンに関連する各種ラベルやタグの割り当てやクエリーなど、SCM のバージョン関連の機能を活用できるようになります。

2.3.4.1.1. API オブジェクトステートのエクスポート

API オブジェクトの仕様は、oc export で取り込む必要があります。この操作は、オブジェクト定義から環境に固有のデータを取り除き (現在の namespace または割り当てられた IP アドレスなど)、異なる環境で再作成できるようにします (オブジェクトのフィルターされていないステートを出力する oc get 操作とは異なります) 。

oc label を使用すると、API オブジェクトに対するラベルの追加、変更、または削除が可能になり、ラベルがあれば、操作 1 回で Pod のグループの選択や管理ができるので、プロモーションフロー用に収集されたオブジェクトを整理するのに有用であることが分かります。oc label を使用すると、適切なオブジェクトをエクスポートするのが簡単になります。また、オブジェクトが新しい環境で作成された場合にラベルが継承されるので、各環境のアプリケーションコンポーネントの管理も簡素化されます。

API オブジェクトには、Secret を参照する DeploymentConfig などの参照が含まれることがよくあります。API オブジェクトをある環境から別の環境へと移動する際、これらの参照も新しい環境へと移動することを確認する必要があります。

同様に DeploymentConfig などの API オブジェクトには、外部レジストリーを参照する ImageStreams の参照が含まれることがよくあります。API オブジェクトをある環境から別の環境へと移動する際、このような参照が新しい環境内で解決可能であることを確認する必要があります。つまり、参照が解決可能であり、ImageStream は新しい環境でアクセス可能なレジストリーを参照できる必要があります。詳細については、「イメージの移動」および「プロモートの注意事項」を参照してください。

2.3.4.1.2. API オブジェクトステートのインポート

2.3.4.1.2.1. 初期作成

アプリケーションを新しい環境に初めて導入する場合は、API オブジェクトの仕様を表現する JSON または YAML を使用し、oc create を実行して適切な環境で作成するだけで十分です。oc create を使用する場合、--save-config オプションに留意してください。アノテーション一覧にオブジェクトの設定要素を保存しておくことで、後の oc apply を使用したオブジェクトの変更が容易になります。

2.3.4.1.2.2. 反復修正

各種のステージング環境が最初に確立されると、プロモートサイクルが開始し、アプリケーションがステージからステージへと移動します。アプリケーションの更新には、アプリケーションの一部である API オブジェクトの修正を含めることができます。API オブジェクトはOpenShift Container Platform システムの設定を表すことから、それらの変更が想定されます。それらの変更の目的として以下のケースが想定されます。

- ステージング環境間における環境の違いについて説明する。

- アプリケーションがサポートする各種シナリオを検証する。

oc CLI を使用することで、API オブジェクトの次のステージ環境への移行が実行されます。API オブジェクトを変更する oc コマンドセットは充実していますが、本トピックではオブジェクト間の差分を計算し、適用する oc apply に焦点を当てます。

とりわけ oc apply は既存のオブジェクト定義と共にファイルまたは標準入力 (stdin) を入力として取る 3 方向マージと見ることができます。以下の間で 3 方向マージを実行します。

- コマンドへの入力

- オブジェクトの現行バージョン

- 現行オブジェクトにアノテーションとして保存された最新のユーザー指定オブジェクト定義

その後に既存のオブジェクトは結果と共に更新されます。

オブジェクトがソース環境とターゲット環境間で同一であることが予期されていない場合など、API オブジェクトの追加のカスタマイズが必要な場合に、oc set などの oc コマンドは、アップストリーム環境から最新のオブジェクト定義を適用した後に、オブジェクトを変更するために使用できます。

使用方法についての詳細は、「シナリオおよび実例」を参照してください。

2.3.4.2. イメージおよびイメージストリームの管理

OpenShift Container Platform のイメージも一連の API オブジェクトで管理されます。ただし、イメージの管理はアプリケーションのプロモートにおける非常に中心的な部分であるため、イメージに最も直接的に関係するツールおよび API オブジェクトについては別途扱います。イメージのプロモートの管理には、手動および自動の方法を使用できます (パイプラインによるイメージの伝搬) 。

2.3.4.2.1. イメージの移動

イメージの管理に関する注意事項すべての詳細については、「イメージの管理」のトピックを参照してください。

2.3.4.2.1.2. ステージング環境が異なるレジストリーを使用する場合

ステージング環境が異なる OpenShift Container Platform レジストリーを活用している場合、より高度な使用方法が見られます。内部レジストリーへのアクセス で、手順を詳細に説明していますが、まとめると以下のようになります。

-

OpenShift Container Platform のアクセストークンの取得と関連して

dockerコマンドを使用し、docker loginコマンドに指定します。 -

OpenShift Container Platform レジストリーにログインした後、

docker pull、docker tagおよびdocker pushを使用してイメージを移行します。 -

イメージがパイプラインの次の環境のレジストリーで利用可能になってから、必要に応じて

oc tagを使用してイメージストリームを設定します。

2.3.4.2.2. デプロイ

変更対象が基礎となるアプリケーションイメージであるか、アプリケーションを設定する API オブジェクトであるかを問わず、プロモートされた変更を認識するにはデプロイメントが通常必要になります。アプリケーションのイメージが変更される場合 (アップストリームからのイメージのプロモートの一環としての oc tag 操作または docker push の実行による場合など)、DeploymentConfig の ImageChangeTriggers が新規デプロイメントをトリガーできます。同様に DeploymentConfig API オブジェクト自体が変更されている場合、API オブジェクトがプロモーション手順によって更新されると (例: oc apply)、ConfigChangeTrigger がデプロイメントを開始できます。

それ以外の場合に、手動のデプロイメントを容易にする oc コマンドには以下が含まれます。

-

oc rollout: デプロイメント管理の新しいアプローチです(停止と再開のセマンティクスおよび履歴管理に関する充実した機能を含む)。 -

oc rollback: 以前のデプロイメントに戻すことができます。プロモーションのシナリオでは、新しいバージョンのテストで問題が発生した場合には、以前のバージョンで問題がないかどうかを確認する必要がある場合があります。

2.3.4.2.3. Jenkins でのプロモーションフローの自動化

アプリケーションをプロモートする際に環境間での移動が必要なアプリケーションのコンポーネントを理解し、コンポーネントを移動する際に必要な手順を理解した後に、ワークフローのオーケストレーションおよび自動化を開始できます。OpenShift Container Platform は、このプロセスで役立つ Jenkins イメージおよびプラグインを提供しています。

OpenShift Container Platform Jenkins のイメージについては、「イメージの使用」で詳細に説明されています。これには Jenkins と Jenkins Pipeline の統合を容易にする OpenShift Container Platform プラグインのセットも含まれます。また、「Pipeline ビルドストラテジー」により、Jenkins Pipeline と OpenShift Container Platform との統合が容易になります。これらすべてはアプリケーションのプロモートを含む、CI/CD のさまざまな側面の有効化に焦点を当てています。

アプリケーションのプロモート手順の手動による実行から自動へと切り替える際には、以下の OpenShift Container Platform が提供する Jenkins 関連の機能に留意してください。

- OpenShift Container Platform は、OpenShift Container Platform クラスターでのデプロイメントを非常に容易なものとするために高度にカスタマイズされた Jenkins のイメージを提供します。

- Jenkins イメージには OpenShift Pipeline プラグインが含まれます。これはプロモーションワークフローを実装する構成要素を提供します。これらの構成要素には、イメージストリームの変更に伴う Jenkins ジョブのトリガーやそれらのジョブ内でのビルドおよびデプロイメントのトリガーも含まれます。

-

OpenShift Container Platform の Jenkins Pipeline のビルドストラテジーを使用する

BuildConfigsにより、Jenkinsfile ベースの Jenkins Pipeline ジョブの実行が可能になります。パイプラインジョブは Jenkins における複雑なプロモーションフロー用の戦略を構成するものであり、OpenShift Pipeline プラグインにより提供される手順を利用できます。

2.3.4.2.4. プロモーションについての注意事項

2.3.4.2.4.1. API オブジェクト参照

API オブジェクトは他のオブジェクトを参照することができます。この一般的な使用方法として、イメージストリームを参照するDeploymentConfig を設定します (他の参照関係も存在する場合があります)。

ある環境から別の環境へと API オブジェクトをコピーする場合、すべての参照がターゲット環境内で解決できることが重要となります。以下のような参照のシナリオを見てみましょう。

- プロジェクトに「ローカル」から参照している場合。この場合、参照オブジェクトは、プロジェクトを参照しているオブジェクトと同じプロジェクトに存在します。通常の方法として、参照しているオブジェクトと同じプロジェクト内にあるターゲット環境に参照オブジェクトをコピーできることを確認します。

他のプロジェクトのオブジェクトを参照する場合。これは、共有プロジェクトのイメージストリームが複数のアプリケーションプロジェクトによって使用されている場合によくあるケースです (「イメージの管理」を参照してください)。この場合、参照するオブジェクトを新しい環境にコピーする際、ターゲット環境内で解決できるように参照を随時更新しなければなりません。以下が必要になる場合があります。

- 共有されるプロジェクトの名前がターゲット環境では異なる場合、参照先のプロジェクトを変更する。

- 参照されるオブジェクトを共有プロジェクトからターゲット環境のローカルプロジェクトへと移動し、主要オブジェクトをターゲット環境へと移動する際に参照をローカルルプロジェクトをポイントするよう更新する。

- 参照されるオブジェクトのターゲット環境へのコピーおよびその参照の更新の他の組み合わせ。

通常は、新しい環境にコピーされるオブジェクトによって参照されるオブジェクトを確認し、参照がターゲット環境で解決可能であることを確認することをお勧めします。それ以外には、参照の修正を行うための適切なアクションを取り、ターゲット環境で参照されるオブジェクトを利用可能にすることができます。

2.3.4.2.4.2. イメージレジストリー参照

イメージストリームはイメージレポジトリーを参照してそれらが表すイメージのソースを示唆します。イメージストリームがある環境から別の環境へと移動する場合、レジストリーおよびレポジトリーの参照も変更すべきかどうかを検討することが重要です。

- テスト環境と実稼働環境間の分離をアサートするために異なるイメージレジストリーが使用されている場合。

- テスト環境および実稼働環境に対応したイメージを分離するために異なるイメージレポジトリーが使用されている場合。

上記のいずれかが該当する場合、イメージストリームはソース環境からターゲット環境にコピーされる際に、適切なイメージに対して解決されるよう変更される必要があります。これは、あるレジストリーおよびレポジトリーから別のレジストリーおよびレポジトリーへとイメージをコピーするという シナリオおよび実例 に説明されている手順の追加として行われます。

2.3.4.3. 概要

現時点で、以下が定義されています。

- デプロイされたアプリケーションを構成する新規アプリケーションアーティファクト。

- アプリケーションのプロモーションアクティビティーと OpenShift Container Platform によって提供されるツールおよびコンセプトとの相関関係。

- OpenShift Container Platform と CI/CD パイプラインエンジン Jenkins との統合。

このトピックにおける残りの部分では、OpenShift Container Platform 内のアプリケーションのプロモーションフローのいくつかの例について扱います。

2.3.5. シナリオおよび実例

Docker、Kubernetes および OpenShift Container Platform のエコシステムにより導入された新規アプリケーションアーティファクトのコンポーネントを定義した上に、このセクションでは OpenShift Container Platform によって提供される方法およびツールを使用してこれらのコンポーネントを環境間でプロモートする方法を説明します。

アプリケーションを構成するコンポーネントにおいて、イメージは主要なアーティファクトです。これを前提とし、かつアプリケーションのプロモーションに当てはめると、中心的なアプリケーションのプロモーションパターンとなるのがイメージのプロモーションであり、この場合にイメージが作業単位となります。ほとんどのアプリケーションプロモーションシナリオでは、プロモーションパイプラインを使用したイメージの管理および伝搬が行われます。

単純なシナリオでは、パイプラインを使用したイメージの管理および伝搬のみを扱います。プロモーションシナリオの対象範囲が広がるにつれ、API オブジェクトを筆頭とする他のアプリケーションアーティファクトがパイプラインで管理および伝搬されるアイテムのインベントリーに含まれます。

このトピックでは、手動および自動の両方のアプローチを使用して、イメージおよび API オブジェクトのプロモートに関する特定の実例をいくつか紹介します。最初にアプリケーションのプロモーションパイプラインの環境のセットアップに関して、以下の点に留意してください。

2.3.5.1. プロモーションのセットアップ

アプリケーションの初期リビジョンの開発が完了すると、次の手順として、プロモーションパイプラインのステージング環境に移行できるようにアプリケーションのコンテンツをパッケージ化します。

最初に、表示されるすべての API オブジェクトを移行可能なものとしてグループ化し、共通の

labelを適用します。labels: promotion-group: <application_name>

labels: promotion-group: <application_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 前述のように

oc labelコマンドは、さまざまな API オブジェクトのラベルの管理を容易にします。ヒントOpenShift Container Platform テンプレートに API オブジェクトを最初に定義する場合、プロモート用にエクスポートする際にクエリーに使用する共通のラベルがすべての関連するオブジェクトにあることを簡単に確認できます。

このラベルは後続のクエリーで使用できます。たとえば、アプリケーションの API オブジェクトの移行を行う以下の

ocコマンドセットの呼び出しについて検討しましょう。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- または、すでに存在している場合は

oc project <target_project>を実行します。

注記oc exportコマンドでは、イメージストリーム用にisタイプを含めるかどうかは、パイプライン内の異なる環境全体でイメージ、イメージストリーム、およびレジストリーの管理方法をどのように選択するかによって変わってきます。この点に関する注意事項を以下で説明しています。イメージの管理 のトピックも参照してください。プロモーションパイプラインの各種のステージング環境で使用されるそれぞれのレジストリーに対して機能するトークンを取得する必要があります。各環境について以下を実行します。

環境にログインします。

oc login <each_environment_with_a_unique_registry>

$ oc login <each_environment_with_a_unique_registry>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下を実行してアクセストークンを取得します。

oc whoami -t

$ oc whoami -tCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 次回に使用できるようにトークン値をコピーアンドペーストします。

2.3.5.2. 繰り返し可能なプロモーションプロセス

パイプラインの異なるステージング環境での初回のセットアップ後に、プロモーションパイプラインを使用したアプリケーションの反復を検証する繰り返し可能な手順のセットを開始できます。これらの基本的な手順は、ソース環境のイメージまたは API オブジェクトが変更されるたびに実行されます。

更新後のイメージの移動→更新後の API オブジェクトの移動→環境固有のカスタマイズの適用

通常、最初の手順ではアプリケーションに関連するイメージの更新をパイプラインの次のステージにプロモートします。前述のように、ステージング環境間で OpenShift Container Platform レジストリーが共有されるかどうかが、イメージをプロモートする上での主要な差別化要因となります。

レジストリーが共有されている場合、単に

oc tagを使用します。oc tag <project_for_stage_N>/<imagestream_name_for_stage_N>:<tag_for_stage_N> <project_for_stage_N+1>/<imagestream_name_for_stage_N+1>:<tag_for_stage_N+1>

$ oc tag <project_for_stage_N>/<imagestream_name_for_stage_N>:<tag_for_stage_N> <project_for_stage_N+1>/<imagestream_name_for_stage_N+1>:<tag_for_stage_N+1>Copy to Clipboard Copied! Toggle word wrap Toggle overflow レジストリーが共有されていない場合、ソースおよび宛先の両方のレジストリーにログインする際、各プロモーションパイプラインレジストリーに対してアクセストークンを使用でき、アプリケーションイメージのプル、タグ付け、およびプッシュを随時実行できます。

ソース環境レジストリーにログインします。

docker login -u <username> -e <any_email_address> -p <token_value> <src_env_registry_ip>:<port>

$ docker login -u <username> -e <any_email_address> -p <token_value> <src_env_registry_ip>:<port>Copy to Clipboard Copied! Toggle word wrap Toggle overflow アプリケーションのイメージをプルします。

docker pull <src_env_registry_ip>:<port>/<namespace>/<image name>:<tag>

$ docker pull <src_env_registry_ip>:<port>/<namespace>/<image name>:<tag>Copy to Clipboard Copied! Toggle word wrap Toggle overflow アプリケーションのイメージを宛先レジストリーの場所にタグ付けし、宛先ステージング環境と一致するように namespace、名前、タグを随時更新します。

docker tag <src_env_registry_ip>:<port>/<namespace>/<image name>:<tag> <dest_env_registry_ip>:<port>/<namespace>/<image name>:<tag>

$ docker tag <src_env_registry_ip>:<port>/<namespace>/<image name>:<tag> <dest_env_registry_ip>:<port>/<namespace>/<image name>:<tag>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 宛先ステージング環境レジストリーにログインします。

docker login -u <username> -e <any_email_address> -p <token_value> <dest_env_registry_ip>:<port>

$ docker login -u <username> -e <any_email_address> -p <token_value> <dest_env_registry_ip>:<port>Copy to Clipboard Copied! Toggle word wrap Toggle overflow イメージを宛先にプッシュします。

docker push <dest_env_registry_ip>:<port>/<namespace>/<image name>:<tag>

$ docker push <dest_env_registry_ip>:<port>/<namespace>/<image name>:<tag>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ヒント外部レジストリーからイメージの新バージョンを自動的にインポートするために、

oc tagコマンドで--scheduledオプションを使用できます。これを使用する場合、ImageStreamTagが参照するイメージは、イメージをホストするレジストリーから定期的にプルされます。

次に、アプリケーションの変化によってアプリケーションを構成する API オブジェクトの根本的な変更や API オブジェクトセットへの追加と削除が必要となるケースがあります。アプリケーションの API オブジェクトにこのような変化が生じると、OpenShift Container Platform CLI はあるステージング環境から次の環境へと変更を移行するための広範囲のオプションを提供します。

プロモーションパイプラインの初回セットアップ時と同じ方法で開始します。

oc login <source_environment> oc project <source_project> oc export dc,is,svc,route,secret,sa -l promotion-group=<application_name> -o yaml > export.yaml oc login <target_environment> oc <target_project>

$ oc login <source_environment> $ oc project <source_project> $ oc export dc,is,svc,route,secret,sa -l promotion-group=<application_name> -o yaml > export.yaml $ oc login <target_environment> $ oc <target_project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 単に新しい環境でリソースを作成するのではなく、それらを更新します。これを実行するための方法がいくつかあります。

より保守的なアプローチとして、

oc applyを使用し、ターゲット環境内の各 API オブジェクトに新しい変更をマージできます。これを実行することにより、--dry-run=trueオプションを実行し、オブジェクトを実際に変更する前に結果として得られるオブジェクトを確認することができます。oc apply -f export.yaml --dry-run=true

$ oc apply -f export.yaml --dry-run=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 問題がなければ、

applyコマンドを実際に実行します。oc apply -f export.yaml

$ oc apply -f export.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow applyコマンドはより複雑なシナリオで役立つ追加の引数をオプションで取ります。詳細についてはoc apply --helpを参照してください。または、よりシンプルで積極的なアプローチとして、

oc replaceを使用できます。この更新および置換についてはドライランは利用できません。最も基本的な形式として、以下を実行できます。oc replace -f export.yaml

$ oc replace -f export.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow applyと同様に、replaceはより高度な動作については他の引数をオプションで取ります。詳細は、oc replace --helpを参照してください。

-

直前の手順では、導入された新しい API オブジェクトは自動的に処理されますが、API オブジェクトがソースの環境から削除された場合には、

oc deleteを使用してこれらをターゲットの環境から手動で削除する必要があります。 ステージング環境ごとに必要な値が異なる可能性があるため、API オブジェクトで引用された環境変数を調整する必要がある場合があります。この場合は

oc set envを使用します。oc set env <api_object_type>/<api_object_ID> <env_var_name>=<env_var_value>

$ oc set env <api_object_type>/<api_object_ID> <env_var_name>=<env_var_value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

最後に、

oc rolloutコマンドまたは、上記の「デプロイメント」のセクションで説明した他のメカニズムを使用して、更新したアプリケーションの新規デプロイメントをトリガーします。

2.3.5.3. Jenkins を使用した反復可能なプロモーションプロセス

OpenShift Container Platform の Jenkins Docker イメージ で定義された OpenShift サンプル ジョブは、Jenkins 構成ベースの OpenShift Container Platform でのイメージのプロモーションの例です。このサンプルのセットアップは OpenShift Origin ソースリポジトリー にあります。

このサンプルには以下が含まれます。

- CI/CD エンジンとして Jenkins の使用。

-

OpenShift Pipeline plug-in for Jenkins の使用。このプラグインでは、Jenkins Freestyle および DSL Job ステップとしてパッケージされた OpenShift Container Platform の

ocCLI が提供する機能サブセットを提供します。ocバイナリーは、OpenShift Container Platform 用の Jenkins Docker イメージにも含まれており、Jenkins ジョブで OpenShift Container Platform と対話するために使用することも可能です。 - OpenShift Container Platform が提供する Jenkins のテンプレート。一時ストレージおよび永続ストレージの両方のテンプレートがあります。

-

サンプルアプリケーション: OpenShift Origin ソースリポジトリー で定義されます。このアプリケーションは

ImageStreams、ImageChangeTriggers、ImageStreamTags、BuildConfigsおよびプロモーションパイプラインの各種ステージに対応した別個のDeploymentConfigsとServicesを利用します。

以下では、OpenShift のサンプルジョブを詳細に検証していきます。

-

最初のステップ は、

oc scale dc frontend --replicas=0の呼び出しと同じです。この手順は、実行されている可能性のあるアプリケーションイメージの以前のバージョンを終了させるために実行されます。 -

2 番目のステップ は

oc start-build frontendの呼び出しと同じです。 -

3 番目のステップ は

oc rollout latest dc/frontendの呼び出しと同じです。 - 4 番目のステップ は、このサンプルの「テスト」を行います。このステップでは、アプリケーションに関連するサービスがネットワークからアクセス可能であることを確認します。背後で、OpenShift Container Platform サービスに関連する IP アドレスやポートにソケット接続を試みます。当然のこととして別のテストを追加することも可能です (OpenShift Pipepline plug-in ステップを使用しない場合は、Jenkins Shell ステップを使用して、OS レベルのコマンドとスクリプトを使用してアプリケーションをテストします)。

-

5 番目のステップ は、アプリケーションがテストに合格したことを前提としているため、イメージは「Ready (使用準備完了)」としてマークされます。このステップでは、新規の prod タグが 最新の イメージをベースにしたアプリケーションイメージ用に作成されます。フロントエンドの

DeploymentConfigで そのタグに対して、ImageChangeTriggerが定義されている場合には、対応する「実稼働」デプロイメントが起動されます。 - 6 番目と最後のステップ は検証のステップで、OpenShift Container Platform が「実稼働」デプロイメントのレプリカを必要なの数を起動したことを確認します。

第3章 認証

3.1. Web コンソール認証

ブラウザーで <master_public_addr>:8443 の「Web コンソール」にアクセスすると、自動的にログインページにリダイレクトされます。

「ブラウザーのバージョンとオペレーティングシステム」を使用して、Web コンソールにアクセスできることを確認します。

このページでログイン認証情報を入力して、API 呼び出しを行うためのトークンを取得します。ログイン後には、「Web コンソール」を使用してプロジェクトをナビゲートできます。

3.2. CLI 認証

CLI コマンドの oc login を使用して、コマンドラインで認証することができます。オプションなしにこのコマンドを実行して、「CLI の使用を開始」できます。

oc login

$ oc loginこのコマンドの対話式フローでは、指定の認証情報を使用して OpenShift Container Platform サーバーへのセッションを確立することができます。OpenShift Container Platform サーバーに正常にログインするための情報がない場合には、必要に応じてコマンドにより、ユーザー入力を求めるプロンプトが出されます。「設定」は自動的に保存され、その後のコマンドすべてに使用されます。

oc login コマンドのすべての設定オプションは oc login --help コマンドの出力で表示されますが、オプションの指定は任意です。以下の例では、一般的なオプションの使用方法を紹介します。

oc login [-u=<username>] \ [-p=<password>] \ [-s=<server>] \ [-n=<project>] \ [--certificate-authority=</path/to/file.crt>|--insecure-skip-tls-verify]

$ oc login [-u=<username>] \

[-p=<password>] \

[-s=<server>] \

[-n=<project>] \

[--certificate-authority=</path/to/file.crt>|--insecure-skip-tls-verify]以下の表では、一般的なオプションを紹介しています。

| オプション | 構文 | 説明 |

|---|---|---|

|

|

oc login -s=<server> |

OpenShift Container Platform サーバーのホスト名を指定します。サーバーがこのフラグで指定されている場合には、このコマンドではホスト名は対話的に確認されません。また、このフラグは、CLI 設定ファイルがある場合や、ログインして別のサーバーに切り替える場合に使用できます。 |

|

|

oc login -u=<username> -p=<password> |

OpenShift Container Platform サーバーにログインするための認証情報を指定できます。これらのフラグを指定してユーザー名またはパスワードを入力した場合は、このコマンドでは、ユーザー名やパスワードが対話的に確認されません。設定ファイルでセッショントークンを確立し、ログインしてから別のユーザー名に切り替える場合に、これらのフラグを使用することができます。 |

|

|

oc login -u=<username> -p=<password> -n=<project> |

|

|

|

oc login --certificate-authority=<path/to/file.crt> |

HTTPS を使用する OpenShift Container Platform サーバーで正常かつセキュアに認証します。認証局ファイルへのパスは指定する必要があります。 |

|

|

oc login --insecure-skip-tls-verify |

HTTPS サーバーとの対話を可能にして、サーバーの証明書チェックを省略します。ただし、これはセキュリティーが確保されない点に注意してください。有効な証明書を提示しない HTTPS サーバーに |

CLI 設定ファイルを使用すると、簡単に「複数の CLI プロファイル」を管理することができます。

管理者認証情報があるのに、「デフォルトシステムユーザー」の system:admin としてログインされていない場合、認証情報が 「CLI 設定ファイル」にある限り、いつでもこのユーザーとしてログインし直すことができます。以下のコマンドはログインを実行し、「デフォルト」プロジェクトに切り替えます。

oc login -u system:admin -n default

$ oc login -u system:admin -n default第4章 承認

4.1. 概要

以下のトピックでは、アプリケーション開発者向けの「認証タスク」と、クラスター管理者が指定する認証機能について紹介します。

4.2. ユーザーの Pod 作成権限の有無の確認

scc-review と scc-subject-review オプションを使用することで、個別ユーザーまたは特定のサービスアカウントのユーザーが Pod を作成または更新可能かどうかを確認できます。

scc-review オプションを使用すると、サービスアカウントが Pod を作成または更新可能かどうかを確認できます。このコマンドは、リソースを許可する SCC (Security Context Constraints) について出力します。

たとえば、system:serviceaccount:projectname:default サービスアカウントのユーザーが Pod を作成可能かどうかを確認するには、以下を実行します。

oc policy scc-review -z system:serviceaccount:projectname:default -f my_resource.yaml

$ oc policy scc-review -z system:serviceaccount:projectname:default -f my_resource.yaml

scc-subject-review オプションを使用して、特定のユーザーが Pod を作成または更新できるかどうかを確認することも可能です。

oc policy scc-subject-review -u <username> -f my_resource.yaml

$ oc policy scc-subject-review -u <username> -f my_resource.yaml特定のグループに所属するユーザーが特定のファイルで Pod を作成できるかどうかを確認するには、以下を実行します。

oc policy scc-subject-review -u <username> -g <groupname> -f my_resource.yaml

$ oc policy scc-subject-review -u <username> -g <groupname> -f my_resource.yaml4.3. 認証済みのユーザーとして何が実行できるのかを判断する方法

OpenShift Container Platform プロジェクト内から、(サードパーティーのリソースを含む) namespace スコープの全リソースに対してどのような 「verb (動詞)」を実行できるのかを判断することができます。

can-i コマンドオプションは、ユーザーとロール関連のスコープをテストします。

oc policy can-i --list --loglevel=8

$ oc policy can-i --list --loglevel=8この出力で、情報収集のために呼び出す API 要求を判断しやすくなります。

ユーザーが判読可能な形式で情報を取得し直すには、以下を実行します。

oc policy can-i --list

$ oc policy can-i --listこの出力では、完全な一覧が表示されます。

特定の verb (動詞) を実行可能かどうかを判断するには、以下を実行します。

oc policy can-i <verb> <resource>

$ oc policy can-i <verb> <resource>「ユーザースコープ」は、指定のスコープに関する詳細情報を提供します。以下に例を示します。

oc policy can-i <verb> <resource> --scopes=user:info

$ oc policy can-i <verb> <resource> --scopes=user:info第5章 プロジェクト

5.1. 概要

「プロジェクト」を使用すると、ユーザーコミュニティーが、他のコミュニティーとは別にコンテンツを整理し、管理することができます。

5.2. プロジェクトの作成

クラスター管理者が 「許可した場合は」、「CLI」または「Web コンソール」を使用して新規プロジェクトを作成することができます。

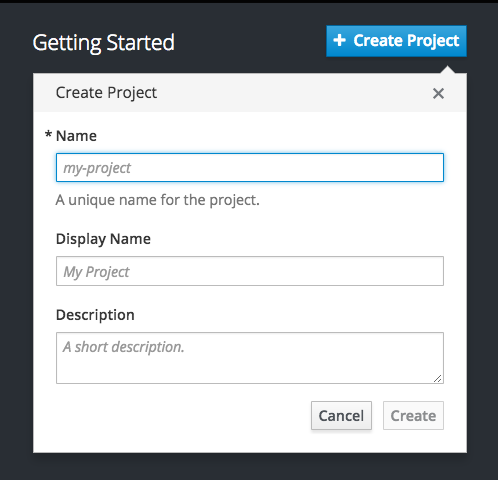

5.2.1. Web コンソールの使用

Web コンソールを使用して新規プロジェクトを作成するには、Project パネルまたは Project ページの Create Project ボタンをクリックします。

Create Project ボタンはデフォルトで表示されていますが、オプションで非表示にしたり、カスタマイズしたりすることができます。

5.2.2. CLI の使用

CLI を使用して新規プロジェクトを作成するには、以下を実行します。

oc new-project <project_name> \

--description="<description>" --display-name="<display_name>"

$ oc new-project <project_name> \

--description="<description>" --display-name="<display_name>"以下に例を示します。

oc new-project hello-openshift \

--description="This is an example project to demonstrate OpenShift v3" \

--display-name="Hello OpenShift"

$ oc new-project hello-openshift \

--description="This is an example project to demonstrate OpenShift v3" \

--display-name="Hello OpenShift"作成可能なプロジェクト数は、「システム管理者が制限することができます」。上限に達すると、既存のプロジェクトを削除してからでないと、新しいプロジェクトは作成できません。

5.3. プロジェクトの表示

プロジェクトを表示する場合は、「認証ポリシー」に基いて、表示アクセスのあるプロジェクトだけを表示できるように制限されます。

プロジェクトの一覧を表示するには、以下を実行します。

oc get projects

$ oc get projectsCLI 操作について現在のプロジェクトから別のプロジェクトに切り換えることができます。その後の操作についてはすべて指定のプロジェクトが使用され、プロジェクトスコープのコンテンツの操作が実行されます。

oc project <project_name>

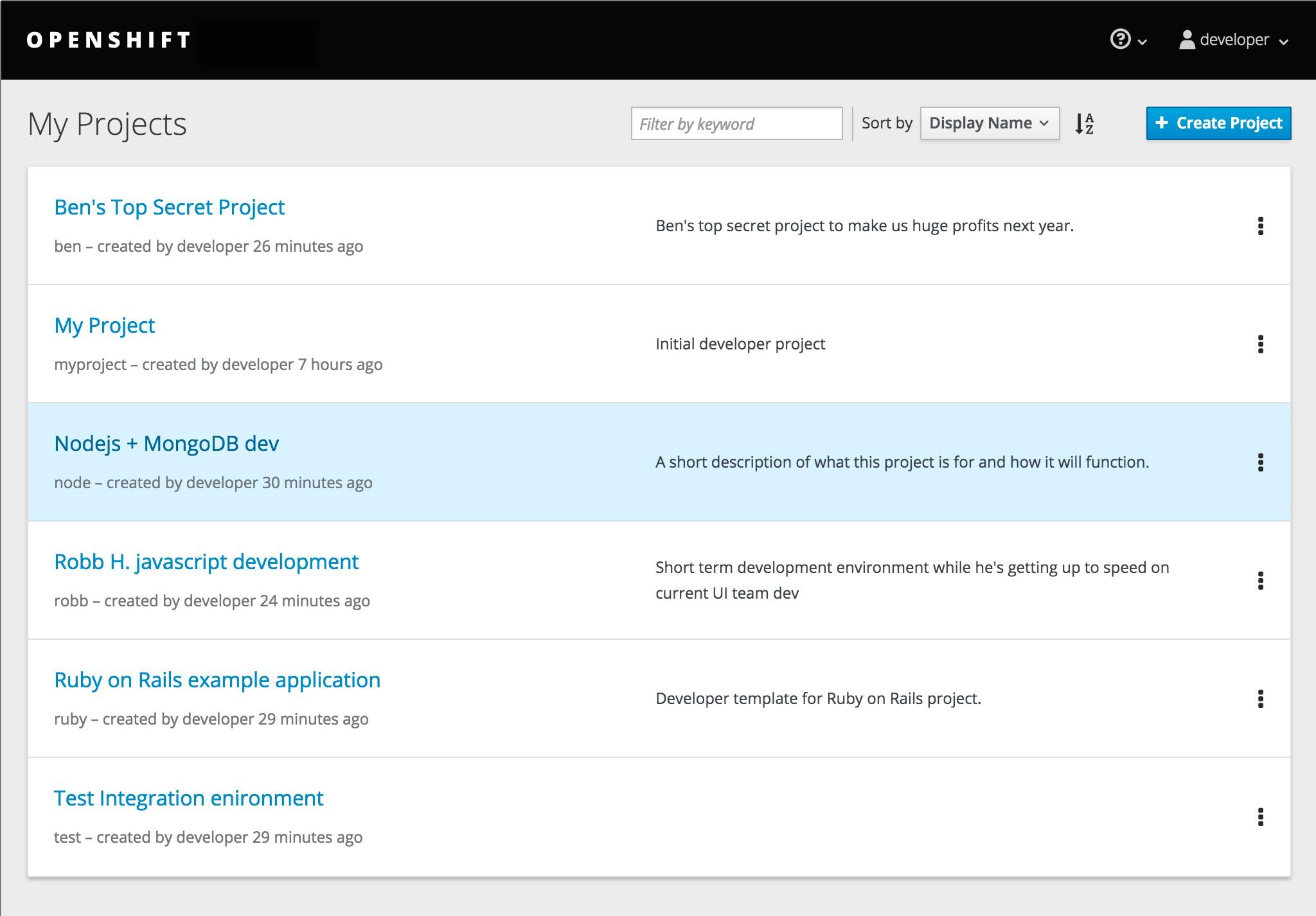

$ oc project <project_name>また、「Web コンソール」を使用してプロジェクト間の表示や切り替えが可能です。「認証」してログインすると、アクセスできるプロジェクト一覧が表示されます。

サービスカタログの右側のパネルでは、最近アクセスしたプロジェクト (最大 5 個) へのクィックアクセスが可能です。プロジェクトの詳細一覧については、右パネルの上部にある View All リンクを使用します。

「CLI」を使用して 「新規プロジェクト」を作成する場合は、ブラウザーでページを更新して、新規プロジェクトを表示できます。

プロジェクトを選択すると、そのプロジェクトの「プロジェクトの概要」が表示されます。

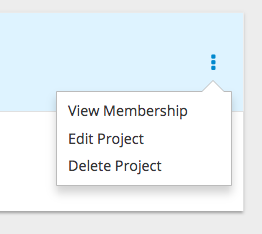

特定プロジェクトの kebab (ケバブ) メニューをクリックすると、以下のオプションが表示されます。

5.4. プロジェクトステータスの確認

oc status コマンドは、コンポーネントと関係を含む現在のコンポーネントの概要を示します。このコマンドには引数は指定できません。

oc status

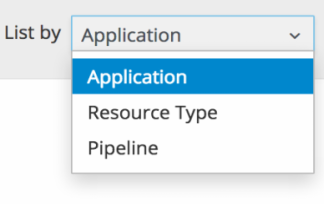

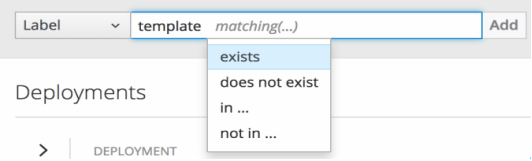

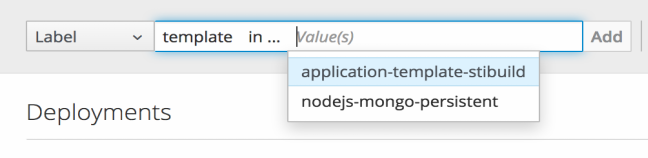

$ oc status5.5. ラベル別の絞り込み

リソースの「ラベル」を使用して、「Web コンソール」のプロジェクトページのコンテンツを絞り込むことができます。提案されたラベル名や値から選択することも、独自の内容を入力することも可能です。また、複数のフィルターを指定することもできます。複数のフィルターが適用される場合には、リソースはすべてのフィルターと一致しないと表示されなくなります。

ラベル別で絞り込むには以下を実行します。

ラベルタイプを選択します。

以下のいずれかを選択します。

exists

ラベル名が存在することを確認するだけで、値は無視します。

does not exist

ラベル名が存在しないことを確認してこの値を無視します。

in

ラベル名が存在し、選択した値の 1 つと同じであることを確認します。

not in

ラベル名が存在しない、または選択した値に該当しないことを確認します。

in または not in を選択した場合には、値セットを選択してから、Filter を選択します。

フィルターの追加後に、Clear all filters を選択するか、削除するフィルターをそれぞれクリックして、絞り込みを停止します。

5.6. ページの状態のブックマーク

OpenShift Container Platform「Web コンソール」では、ページの状態をブックマークできるようになり、ラベルのフィルターや他の設定を保存する場合に役立ちます。

タブ間の切り替えなど、ページの状態を変更する作業を行った場合には、ブラウザーのナビゲーションバーの URL が自動的に更新されます。

5.7. プロジェクトの削除

プロジェクトを削除すると、サーバーは Terminating から Active にプロジェクトのステータスを更新します。次にサーバーは、Terminating の状態のプロジェクトからコンテンツをすべて削除してから、プロジェクトを最終的に削除します。プロジェクトが Terminating のステータスの間は、ユーザーはそのプロジェクトに新規コンテンツを追加できません。プロジェクトは、CLI または Web コンソールで削除できます。

CLI を使用してプロジェクトを削除するには以下を実行します。

oc delete project <project_name>

$ oc delete project <project_name>第6章 アプリケーションの移行

6.1. 概要

以下のトピックでは、OpenShift version 2 (v2) アプリケーションから OpenShift version 3 (v3) に移行する手順を説明します。

以下のトピックでは、OpenShift v2 に固有の用語を使用します。「「OpenShift Enterprise 2 と OpenShift Enterprise 3 の比較」では、これら 2 つのバージョンや、使用する用語の違いについて詳しく説明しています。

OpenShift v2 アプリケーションから OpenShift Container Platform v3 に移行するには、各 v2 カートリッジは OpenShift Container Platform v3 の対応のイメージまたはテンプレートと同等であり、個別に移行する必要があるので、v2 アプリケーションのすべてのカートリッジを記録する必要があります。またそれぞれのカートリッジについて、すべての依存関係または必要なパッケージは v3 イメージに含める必要があるため、それらを記録する必要もあります。

一般的な移行手順は以下のとおりです。

v2 アプリケーションをバックアップします。

- Web カートリッジ: ソースコードは、GitHub のリポジトリーにプッシュするなど、Git リポジトリーにバックアップすることができます。

-

データベースカートリッジ: データベースは、dump コマンドを使用してバックアップすることができます (

mongodump、mysqldump、pg_dump)。 Web およびデータベースカートリッジ:

rhcクライアントツールには、複数のカートリッジをバックアップするスナップショットの機能があります。rhc snapshot save <app_name>

$ rhc snapshot save <app_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow スナップショットは展開可能な tar ファイルであり、このファイルには、アプリケーションのソースコードとデータベースのダンプが含まれます。

- アプリケーションにデータベースカートリッジが含まれる場合には、v3 データベースアプリケーションを作成し、データベースダンプを新しい v3 データベースアプリケーションの Pod に同期してから、データベースの復元コマンドを使用して v3 データベースアプリケーションに v2 データベースを復元します。

- Web フレームワークアプリケーションの場合には、v3 と互換性を持たせるようにアプリケーションのソースコードを編集してから、Git リポジトリーの適切なファイルに、必要な依存関係やパッケージを追加します。v2 環境変数を適切な v3 環境変数に変換します。

- ソース (Git リポジトリー) または Git URL のクイックスタートから v3 アプリケーションを作成します。また、データベースのサービスパラメーターを新規アプリケーションに追加して、データベースアプリケーションと Web アプリケーションをリンクします。

- v2 には統合 git 環境があり、アプリケーションは v2 git リポジトリーに変更がプッシュされるたびに自動的に再ビルドされ、再起動されます。v3 では、ビルドがパブリックの git リポジトリーにプッシュされるソースコードの変更で自動的にトリガーされるようにするために、v3 の初期ビルドの完了後に webhook を設定する必要があります。

6.2. データベースアプリケーションの移行

6.2.1. 概要

以下のトピックでは、MySQL、PostgreSQL および MongoDB データベースアプリケーションを OpenShift バージョン 2 (v2) から OpenShift version 3 (v3) に移行する方法を確認します。

6.2.2. サポートされているデータベース

| v2 | v3 |

|---|---|

|

MongoDB: 2.4 |

MongoDB: 2.4、2.6 |

|

MySQL: 5.5 |

MySQL: 5.5、5.6 |

|

PostgreSQL: 9.2 |

PostgreSQL: 9.2、9.4 |

6.2.3. MySQL

すべてのデータベースをダンプファイルにエクスポートして、これをローカルマシン (現在のディレクトリー) にコピーします

rhc ssh <v2_application_name> mysqldump --skip-lock-tables -h $OPENSHIFT_MYSQL_DB_HOST -P ${OPENSHIFT_MYSQL_DB_PORT:-3306} -u ${OPENSHIFT_MYSQL_DB_USERNAME:-'admin'} \ --password="$OPENSHIFT_MYSQL_DB_PASSWORD" --all-databases > ~/app-root/data/all.sql exit$ rhc ssh <v2_application_name> $ mysqldump --skip-lock-tables -h $OPENSHIFT_MYSQL_DB_HOST -P ${OPENSHIFT_MYSQL_DB_PORT:-3306} -u ${OPENSHIFT_MYSQL_DB_USERNAME:-'admin'} \ --password="$OPENSHIFT_MYSQL_DB_PASSWORD" --all-databases > ~/app-root/data/all.sql $ exitCopy to Clipboard Copied! Toggle word wrap Toggle overflow dbdump をローカルマシンにダウンロードします。

mkdir mysqldumpdir rhc scp -a <v2_application_name> download mysqldumpdir app-root/data/all.sql

$ mkdir mysqldumpdir $ rhc scp -a <v2_application_name> download mysqldumpdir app-root/data/all.sqlCopy to Clipboard Copied! Toggle word wrap Toggle overflow テンプレートから v3 mysql-persistent Pod を作成します。

oc new-app mysql-persistent -p \ MYSQL_USER=<your_V2_mysql_username> -p \ MYSQL_PASSWORD=<your_v2_mysql_password> -p MYSQL_DATABASE=<your_v2_database_name>

$ oc new-app mysql-persistent -p \ MYSQL_USER=<your_V2_mysql_username> -p \ MYSQL_PASSWORD=<your_v2_mysql_password> -p MYSQL_DATABASE=<your_v2_database_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Pod の使用準備ができているかどうかを確認します。

oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod の実行中に、データベースのアーカイブファイルを v3 MySQL Pod にコピーします。

oc rsync /local/mysqldumpdir <mysql_pod_name>:/var/lib/mysql/data

$ oc rsync /local/mysqldumpdir <mysql_pod_name>:/var/lib/mysql/dataCopy to Clipboard Copied! Toggle word wrap Toggle overflow v3 の実行中の Pod に、データベースを復元します。

oc rsh <mysql_pod> cd /var/lib/mysql/data/mysqldumpdir

$ oc rsh <mysql_pod> $ cd /var/lib/mysql/data/mysqldumpdirCopy to Clipboard Copied! Toggle word wrap Toggle overflow v3 では、データベースを復元するには、root ユーザーとして MySQL にアクセスする必要があります。

v2 では、

$OPENSHIFT_MYSQL_DB_USERNAMEには全データベースに対する完全な権限がありました。v3 では、権限をデータベースごとに$MYSQL_USERに割り当てる必要があります。mysql -u root source all.sql

$ mysql -u root $ source all.sqlCopy to Clipboard Copied! Toggle word wrap Toggle overflow <dbname> のすべての権限を

<your_v2_username>@localhostに割り当ててから、権限をフラッシュします。Pod からダンプディレクトリーを削除します。

cd ../; rm -rf /var/lib/mysql/data/mysqldumpdir

$ cd ../; rm -rf /var/lib/mysql/data/mysqldumpdirCopy to Clipboard Copied! Toggle word wrap Toggle overflow

サポート対象の MySQL 環境変数

| v2 | v3 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| |

|

| |

|

| |

|

| |

|

| |

|

|

6.2.4. PostgreSQL

ギアから v2 PostgreSQL データベースをバックアップします。

rhc ssh -a <v2-application_name> mkdir ~/app-root/data/tmp pg_dump <database_name> | gzip > ~/app-root/data/tmp/<database_name>.gz

$ rhc ssh -a <v2-application_name> $ mkdir ~/app-root/data/tmp $ pg_dump <database_name> | gzip > ~/app-root/data/tmp/<database_name>.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルマシンに、バックアップファイルを展開します。

rhc scp -a <v2_application_name> download <local_dest> app-root/data/tmp/<db-name>.gz gzip -d <database-name>.gz

$ rhc scp -a <v2_application_name> download <local_dest> app-root/data/tmp/<db-name>.gz $ gzip -d <database-name>.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記手順 4 とは別のフォルダーにバックアップファイルを保存します。

新規サービスを作成するための v2 アプリケーションのデータベース名、ユーザー名、パスワードを使用して PostgreSQL サービスを作成します。

oc new-app postgresql-persistent -p POSTGRESQL_DATABASE=dbname -p POSTGRESQL_PASSWORD=password -p POSTGRESQL_USER=username

$ oc new-app postgresql-persistent -p POSTGRESQL_DATABASE=dbname -p POSTGRESQL_PASSWORD=password -p POSTGRESQL_USER=usernameCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod の使用準備ができているかどうかを確認します。

oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod を実行中に、バックアップディレクトリーを Pod に同期します。

oc rsync /local/path/to/dir <postgresql_pod_name>:/var/lib/pgsql/data

$ oc rsync /local/path/to/dir <postgresql_pod_name>:/var/lib/pgsql/dataCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod にリモートからアクセスします。

oc rsh <pod_name>

$ oc rsh <pod_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow データベースを復元します。

psql dbname < /var/lib/pgsql/data/<database_backup_file>

psql dbname < /var/lib/pgsql/data/<database_backup_file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 必要のなくなったバックアップファイルをすべて削除します。

rm /var/lib/pgsql/data/<database-backup-file>

$ rm /var/lib/pgsql/data/<database-backup-file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

サポート対象の PostgreSQL 環境変数

| v2 | v3 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

|

6.2.5. MongoDB

- OpenShift v3 の場合: MongoDB シェルバージョン 3.2.6

- OpenShift v2 の場合: MongoDB シェルバージョン 2.4.9

sshコマンドを使用して、v2 アプリケーションにリモートからアクセスします。rhc ssh <v2_application_name>

$ rhc ssh <v2_application_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -d <database_name> -c <collections>で単一のデータベースを指定して、mongodump を実行します。このオプションがないと、データベースはすべてダンプされます。各データベースは、独自のディレクトリーにダンプされます。mongodump -h $OPENSHIFT_MONGODB_DB_HOST -o app-root/repo/mydbdump -u 'admin' -p $OPENSHIFT_MONGODB_DB_PASSWORD cd app-root/repo/mydbdump/<database_name>; tar -cvzf dbname.tar.gz exit

$ mongodump -h $OPENSHIFT_MONGODB_DB_HOST -o app-root/repo/mydbdump -u 'admin' -p $OPENSHIFT_MONGODB_DB_PASSWORD $ cd app-root/repo/mydbdump/<database_name>; tar -cvzf dbname.tar.gz $ exitCopy to Clipboard Copied! Toggle word wrap Toggle overflow dbdump を mongodump ディレクトリーのローカルマシンにダウンロードします。

mkdir mongodump rhc scp -a <v2 appname> download mongodump \ app-root/repo/mydbdump/<dbname>/dbname.tar.gz

$ mkdir mongodump $ rhc scp -a <v2 appname> download mongodump \ app-root/repo/mydbdump/<dbname>/dbname.tar.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow v3 で MongoDB Pod を実行します。最新のイメージ (3.2.6) には mongo-tools が含まれないので、

mongorestoreまたはmongoimportコマンドを使用するには、デフォルトのmongodb-persistent テンプレートを編集して、mongo-tools, “mongodb:2.4”を含むイメージタグを指定します。このため、以下のoc exportコマンドを使用して、編集することが必要です。oc export template mongodb-persistent -n openshift -o json > mongodb-24persistent.json

$ oc export template mongodb-persistent -n openshift -o json > mongodb-24persistent.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow mongodb-24persistent.json の L80 を編集します。

mongodb:latestはmongodb:2.4に置き換えてください。Copy to Clipboard Copied! Toggle word wrap Toggle overflow mongodb Pod の実行中に、データベースのアーカイブファイルを v3 MongoDB Pod にコピーします。

oc rsync local/path/to/mongodump <mongodb_pod_name>:/var/lib/mongodb/data oc rsh <mongodb_pod>

$ oc rsync local/path/to/mongodump <mongodb_pod_name>:/var/lib/mongodb/data $ oc rsh <mongodb_pod>Copy to Clipboard Copied! Toggle word wrap Toggle overflow MongoDB Pod で、復元する各データベースについて以下を実行します。

cd /var/lib/mongodb/data/mongodump tar -xzvf dbname.tar.gz mongorestore -u $MONGODB_USER -p $MONGODB_PASSWORD -d dbname -v /var/lib/mongodb/data/mongodump

$ cd /var/lib/mongodb/data/mongodump $ tar -xzvf dbname.tar.gz $ mongorestore -u $MONGODB_USER -p $MONGODB_PASSWORD -d dbname -v /var/lib/mongodb/data/mongodumpCopy to Clipboard Copied! Toggle word wrap Toggle overflow データベースが復元されたかどうかを確認します。

mongo admin -u $MONGODB_USER -p $MONGODB_ADMIN_PASSWORD use dbname show collections exit

$ mongo admin -u $MONGODB_USER -p $MONGODB_ADMIN_PASSWORD $ use dbname $ show collections $ exitCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod から mongodump ディレクトリーを削除します。

rm -rf /var/lib/mongodb/data/mongodump

$ rm -rf /var/lib/mongodb/data/mongodumpCopy to Clipboard Copied! Toggle word wrap Toggle overflow

サポート対象の MongoDB 環境変数

| v2 | v3 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

|

6.3. Web フレームワークアプリケーションの移行

6.3.1. 概要

以下のトピックでは、Python、Ruby、PHP、Perl、Node.js、WordPress、Ghost、JBoss EAP、JBoss WS (Tomcat) および Wildfly 10 (JBoss AS) の Web フレームワークアプリケーションを OpenShift version 2 (v2) から OpenShift version 3 (v3) に移行する方法を確認します。

6.3.2. Python

新しい GitHub リポジトリーを設定して、そのリポジトリーをリモートのブランチとして現在のローカル v2 Git リポジトリーに追加します。

git remote add <remote-name> https://github.com/<github-id>/<repo-name>.git

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>.gitCopy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルの v2 ソースコードを新規リポジトリーにプッシュします。

git push -u <remote-name> master

$ git push -u <remote-name> masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow setup.py、wsgi.py、requirements.txt および etc などの重要なファイルがすべて新規リポジトリーにプッシュされていることを確認します。

- アプリケーションに必要なパッケージがすべて requirements.txt に含まれていることを確認します。

ocコマンドを使用して、ビルダーイメージとソースコードから新規の Python アプリケーションを起動します。oc new-app --strategy=source python:3.3~https://github.com/<github-id>/<repo-name> --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>

$ oc new-app --strategy=source python:3.3~https://github.com/<github-id>/<repo-name> --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

サポート対象の Python バージョン

| v2 | v3 |

|---|---|

|

Python: 2.6、2.7、3.3 | |

|

Django |

Django-psql-example (quickstart) |

6.3.3. Ruby

新しい GitHub リポジトリーを設定して、そのリポジトリーをリモートのブランチとして現在のローカル v2 Git リポジトリーに追加します。

git remote add <remote-name> https://github.com/<github-id>/<repo-name>.git

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>.gitCopy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルの v2 ソースコードを新規リポジトリーにプッシュします。

git push -u <remote-name> master

$ git push -u <remote-name> masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow Gemfile がなく、単純な rack アプリケーションを実行している場合には、この Gemfile ファイルをソースの root にコピーします。

https://github.com/sclorg/ruby-ex/blob/master/Gemfile

https://github.com/sclorg/ruby-ex/blob/master/GemfileCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記Ruby 2.0 がサポートする rack gem の最新バージョンは 1.6.4 であるため、Gemfile は

gem 'rack', “1.6.4”に変更する必要があります。Ruby 2.2 以降の場合は、rack gem 2.0 以降を使用してください。

ocコマンドを使用して、ビルダーイメージとソースコードから新規の Ruby アプリケーションを起動します。oc new-app --strategy=source ruby:2.0~https://github.com/<github-id>/<repo-name>.git

$ oc new-app --strategy=source ruby:2.0~https://github.com/<github-id>/<repo-name>.gitCopy to Clipboard Copied! Toggle word wrap Toggle overflow

サポート対象の Ruby バージョン

| v2 | v3 |

|---|---|

|

Ruby: 1.8、1.9、2.0 | |

|

Ruby on Rails: 3、4 |

Rails-postgresql-example (quickstart) |

|

Sinatra |

6.3.4. PHP

新しい GitHub リポジトリーを設定して、そのリポジトリーをリモートのブランチとして現在のローカル v2 Git リポジトリーに追加します。

git remote add <remote-name> https://github.com/<github-id>/<repo-name>

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルの v2 ソースコードを新規リポジトリーにプッシュします。

git push -u <remote-name> master

$ git push -u <remote-name> masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow ocコマンドを使用して、ビルダーイメージとソースコードから新規の PHP アプリケーションを起動します。oc new-app https://github.com/<github-id>/<repo-name>.git --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>

$ oc new-app https://github.com/<github-id>/<repo-name>.git --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

サポート対象の PHP バージョン

| v2 | v3 |

|---|---|

|

PHP: 5.3、5.4 | |

|

PHP 5.4 with Zend Server 6.1 | |

|

CodeIgniter 2 | |

|

HHVM | |

|

Laravel 5.0 | |

|

cakephp-mysql-example (quickstart) |

6.3.5. Perl

新しい GitHub リポジトリーを設定して、そのリポジトリーをリモートのブランチとして現在のローカル v2 Git リポジトリーに追加します。

git remote add <remote-name> https://github.com/<github-id>/<repo-name>

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルの v2 ソースコードを新規リポジトリーにプッシュします。

git push -u <remote-name> master

$ git push -u <remote-name> masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルの Git リポジトリーを編集して、変更をアップストリームにプッシュして、v3 との互換性を確保します。

v2 では、CPAN モジュールは .openshift/cpan.txt にあり、v3 では s2i ビルダーは、ソースの root ディレクトリーで cpanfile という名前のファイルを検索します。

cd <local-git-repository> mv .openshift/cpan.txt cpanfile

$ cd <local-git-repository> $ mv .openshift/cpan.txt cpanfileCopy to Clipboard Copied! Toggle word wrap Toggle overflow cpanfile の形式が若干異なるので、これを編集します。

Expand cpanfile の形式 cpan.txt の形式 requires ‘cpan::mod’;

cpan::mod

requires ‘Dancer’;

Dancer

requires ‘YAML’;

YAML

.openshift ディレクトリーを削除します。

注記v3 では、action_hooks および cron タスクは同じようにサポートされません。詳細情報は、「アクションフック」を参照してください。

-

ocコマンドを使用して、ビルダーイメージとソースコードから新規の Perl アプリケーションを起動します。

oc new-app https://github.com/<github-id>/<repo-name>.git

$ oc new-app https://github.com/<github-id>/<repo-name>.gitサポート対象の Perl バージョン

| v2 | v3 |

|---|---|

|

Perl: 5.10 | |

|

Dancer-mysql-example (quickstart) |

6.3.6. Node.js

新しい GitHub リポジトリーを設定して、そのリポジトリーをリモートのブランチとして現在のローカル Git リポジトリーに追加します。

git remote add <remote-name> https://github.com/<github-id>/<repo-name>

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルの v2 ソースコードを新規リポジトリーにプッシュします。

git push -u <remote-name> master

$ git push -u <remote-name> masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルの Git リポジトリーを編集して、変更をアップストリームにプッシュして、v3 との互換性を確保します。

.openshift ディレクトリーを削除します。

注記v3 では、action_hooks および cron タスクは同じようにサポートされません。詳細情報は、「アクションフック」を参照してください。

server.js を編集します。

- L116 server.js: 'self.app = express();'

- L25 server.js: self.ipaddress = '0.0.0.0';

L26 server.js: self.port = 8080;

注記Lines(L) は V2 カートリッジの server.js から取得されます。

ocコマンドを使用して、ビルダーイメージとソースコードから新規の Node.js アプリケーションを起動します。oc new-app https://github.com/<github-id>/<repo-name>.git --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>

$ oc new-app https://github.com/<github-id>/<repo-name>.git --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

サポート対象の Node.js バージョン

| v2 | v3 |

|---|---|

|

Node.js 0.10 | |

|

Nodejs-mongodb-example。このクイックスタートテンプレートは Node.js バージョン 6 のみをサポートします。 |

6.3.7. WordPress

現時点で WordPress アプリケーションの移行はコミュニティーによるサポートのみで、Red hat のサポートはありません。

WordPress アプリケーションの OpenShift Container Platform v3 への移行に関する情報は、「OpenShift ブログ」を参照してください。

6.3.8. Ghost

現時点で Ghost アプリケーションの移行はコミュニティーによるサポートのみで、Red hat のサポートはありません。

Ghost アプリケーションの OpenShift Container Platform v3 への移行に関する情報は、「OpenShift ブログ」を参照してください。

6.3.9. JBoss EAP

新しい GitHub リポジトリーを設定して、そのリポジトリーをリモートのブランチとして現在のローカル Git リポジトリーに追加します。

git remote add <remote-name> https://github.com/<github-id>/<repo-name>

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルの v2 ソースコードを新規リポジトリーにプッシュします。

git push -u <remote-name> master

$ git push -u <remote-name> masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow - リポジトリーに事前にビルドされた .war ファイルが含まれている場合には、それらをリポジトリーの root ディレクトリー内の deployments ディレクトリーに置く必要があります。

JBoss EAP 7 ビルダーイメージ (jboss-eap70-openshift) と GitHub からのソースコードリポジトリーを使用して新規アプリケーションを作成します。

oc new-app --strategy=source jboss-eap70-openshift:1.6~https://github.com/<github-id>/<repo-name>.git

$ oc new-app --strategy=source jboss-eap70-openshift:1.6~https://github.com/<github-id>/<repo-name>.gitCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.3.10. JBoss WS (Tomcat)

新しい GitHub リポジトリーを設定して、そのリポジトリーをリモートのブランチとして現在のローカル Git リポジトリーに追加します。

git remote add <remote-name> https://github.com/<github-id>/<repo-name>

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルの v2 ソースコードを新規リポジトリーにプッシュします。

git push -u <remote-name> master

$ git push -u <remote-name> masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow - リポジトリーに事前にビルドされた .war ファイルが含まれている場合には、それらをリポジトリーの root ディレクトリー内の deployments ディレクトリーに置く必要があります。

JBoss Web Server 3 (Tomcat 7) ビルダーイメージ (jboss-webserver30-tomcat7) と GitHub からのソースコードリポジトリーを使用して新規アプリケーションを作成します。

oc new-app --strategy=source jboss-webserver30-tomcat7-openshift~https://github.com/<github-id>/<repo-name>.git --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>

$ oc new-app --strategy=source jboss-webserver30-tomcat7-openshift~https://github.com/<github-id>/<repo-name>.git --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.3.11. JBoss AS (Wildfly 10)

新しい GitHub リポジトリーを設定して、そのリポジトリーをリモートのブランチとして現在のローカル Git リポジトリーに追加します。

git remote add <remote-name> https://github.com/<github-id>/<repo-name>

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルの v2 ソースコードを新規リポジトリーにプッシュします。

git push -u <remote-name> master

$ git push -u <remote-name> masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルの Git リポジトリーを編集して、変更をアップストリームにプッシュして v3 との互換性を確保します。

.openshift ディレクトリーを削除します。

注記v3 では、action_hooks および cron タスクは同じようにサポートされません。詳細情報は、「アクションフック」を参照してください。

- deployments ディレクトリーをソースリポジトリーの root に追加します。.war ファイルをこの「deployments」ディレクトリーに移動します。

ocコマンドを使用して、ビルダーイメージとソースコードから新規の Wildfly アプリケーションを起動します。oc new-app https://github.com/<github-id>/<repo-name>.git --image-stream=”openshift/wildfly:10.0" --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>

$ oc new-app https://github.com/<github-id>/<repo-name>.git --image-stream=”openshift/wildfly:10.0" --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記引数

--nameはアプリケーション名を指定するためのオプションの引数です。また、-eはOPENSHIFT_PYTHON_DIRなどのビルドやデプロイメントプロセスに必要な環境変数を追加するためのオプションの引数です。

6.3.12. サポート対象の JBoss バージョン

| v2 | v3 |

|---|---|

|

JBoss App Server 7 | |

|

Tomcat 6 (JBoss EWS 1.0) | |

|

Tomcat 7 (JBoss EWS 2.0) | |

|

Vert.x 2.1 | |

|

WildFly App Server 10 | |

|

WildFly App Server 8.2.1.Final | |

|

WildFly App Server 9 | |

|

CapeDwarf | |

|

JBoss Data Virtualization 6 | |

|

JBoss Enterprise App Platform (EAP) 6 | |

|

JBoss Unified Push Server 1.0.0.Beta1、Beta2 | |

|

JBoss BPM Suite | |

|

JBoss BRMS | |

|

jboss-eap70-openshift: 1.3-Beta | |

|

eap64-https-s2i | |

|

eap64-mongodb-persistent-s2i | |

|

eap64-mysql-persistent-s2i | |

|

eap64-psql-persistent-s2i |

6.4. クイックスタートの例

6.4.1. 概要

v2 クイックスタートから v3 クイックスタートへの明確な移行パスはありませんが、v3 では以下のクイックスタートを利用できます。データベースを含むアプリケーションがある場合には、oc new-app でアプリケーションを作成してから、もう一度 oc new-app を実行して別のデータベースサービスを起動し、これら 2 つを共通の環境変数を使用してリンクするのではなく、以下のいずれかを使用し、ソースコードを含む GitHub リポジトリーからリンクしたアプリケーションとデータベースを一度にインスタンス化できます。oc get templates -n openshift で利用可能なテンプレートをすべて表示することができます。

CakePHP MySQL https://github.com/sclorg/cakephp-ex

- テンプレート: cakephp-mysql-example

Node.js MongoDB https://github.com/sclorg/nodejs-ex

- テンプレート: nodejs-mongodb-example

Django PosgreSQL https://github.com/sclorg/django-ex

- テンプレート: django-psql-example

Dancer MySQL https://github.com/sclorg/dancer-ex

- テンプレート: dancer-mysql-example

Rails PostgreSQL https://github.com/sclorg/rails-ex

- テンプレート: rails-postgresql-example

6.4.2. ワークフロー

上記のテンプレート URL のいずれかに対して git clone をローカルで実行します。アプリケーションのソースコードを追加し、コミットし、GitHub リポジトリーにプッシュしてから、上記のテンプレートのいずれかで v3 クイックスタート アプリケーションを起動します。

- アプリケーション用の GitHub リポジトリーを作成します。

クイックスタートテンプレートのクローンを作成して、GitHub リポジトリーをリモートとして追加します。

git clone <one-of-the-template-URLs-listed-above> cd <your local git repository> git remote add upstream <https://github.com/<git-id>/<quickstart-repo>.git> git push -u upstream master

$ git clone <one-of-the-template-URLs-listed-above> $ cd <your local git repository> $ git remote add upstream <https://github.com/<git-id>/<quickstart-repo>.git> $ git push -u upstream masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow ソースコードを GitHub にコミットし、プッシュします。

cd <your local repository> git commit -am “added code for my app” git push origin master

$ cd <your local repository> $ git commit -am “added code for my app” $ git push origin masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow v3 で新規アプリケーションを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- MongoDB にのみ該当します。

web フレームワーク Pod とデータベース Pod の 2 つの Pod が実行され、web フレームワーク Pod 環境は、データベース Pod 環境と一致しているはずです。

oc set env pod/<pod_name> --listを使用して、環境変数を表示できます。-

DATABASE_NAMEは<DB_SERVICE>_DATABASEになります。 -

DATABASE_USERは<DB_SERVICE>_USERになります。 -

DATABASE_PASSWORDは<DB_SERVICE>_PASSWORDになります。 DATABASE_ADMIN_PASSWORDはMONGODB_ADMIN_PASSWORDになります (MongoDB のみに該当します)。SOURCE_REPOSITORY_URLが指定されていない場合、テンプレートはソースリポジトリーとして上記のテンプレート URL (https://github.com/openshift/<quickstart>-ex) を使用して、hello-welcome アプリケーションが起動します。

-

データベースを移行する場合は、データベースをダンプファイルにエクスポートして、新しい v3 データベース Pod にデータベースを復元します。「データベースアプリケーション」に記載の手順を参照してください。ただし、データベース Pod はすでに実行中であるため、

oc new-appの手順は省略してください。

6.5. 継続的インテグレーションまたは継続的デプロイ (CI/CD)

6.5.1. 概要

以下のトピックでは、OpenShift バージョン 2 (v2) と OpenShift バージョン 3 (v3) 間の継続的インテグレーションおよびデプロイメント (CI/CD) アプリケーションの相違点と、これらのアプリケーションを v3 環境に移行する方法を確認します。

6.5.2. Jenkins

Jenkins アプリケーションは、アーキテクチャーの根本的な違いにより OpenShift バージョン 2 (v2) と OpenShift バージョン 3 (v3) では異なる方法で設定されます。たとえば、v2 ではアプリケーションはギアでホストされる統合型の Git リポジトリーを使用してソースコードを保存します。v3 では、ソースコードは Pod の外部でホストされるパブリックまたはプライベート Git リポジトリーに置かれます。

さらに OpenShift v3 では、Jenkins ジョブは、ソースコードの変更だけでなく、ソースコードと共にアプリケーションをビルドするために使用されるイメージの変更である ImageStream の変更によってもトリガーされます。そのため、v3 で新しい Jenkins アプリケーションを作成してから、OpenShift v3 環境に適した設定でジョブを作成し直して Jenkins アプリケーションを手動で移行することを推奨します。

Jenkins アプリケーションの作成、ジョブの設定、Jenkins プラグインの正しい使用の方法に関する詳細は、以下のリソースを参照してください。

6.6. Webhook およびアクションフック

6.6.1. 概要

以下のトピックでは、OpenShift バージョン 2 (v2) と OpenShift バージョン 3 (v3) 間の webhook とアクションフックの相違点と、これらのアプリケーションの v3 環境への移行方法について説明します。

6.6.2. Webhook

GitHub リポジトリーから

BuildConfigを作成した後に、以下を実行します。oc describe bc/<name-of-your-BuildConfig>

$ oc describe bc/<name-of-your-BuildConfig>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のように、上記のコマンドは webhook GitHub URL を出力します。

<https://api.starter-us-east-1.openshift.com:443/oapi/v1/namespaces/nsname/buildconfigs/bcname/webhooks/secret/github>.

<https://api.starter-us-east-1.openshift.com:443/oapi/v1/namespaces/nsname/buildconfigs/bcname/webhooks/secret/github>.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - GitHub の Web コンソールから、この URL を GitHub にカットアンドペーストします。

- GitHub リポジトリーで、Settings → Webhooks & Services から Add Webhook を選択します。

- Payload URL フィールドに、(上記と同様の) URL の出力を貼り付けます。

-

Content Type を

application/jsonに設定します。 - Add webhook をクリックします。

webhook の設定が正常に完了したことを示す GitHub のメッセージが表示されます。

これで変更を GitHub リポジトリーにプッシュするたびに新しいビルドが自動的に起動し、ビルドに成功すると新しいデプロイメントが起動します。

アプリケーションを削除または再作成する場合には、GitHub の Payload URL フィールドを BuildConfig webhook url で更新する必要があります。

6.6.3. アクションフック

OpenShift バージョン 2 (v2) では、.openshift/action_hooks ディレクトリーに build、deploy、post_deploy および pre_build スクリプトまたは action_hooks が置かれます。v3 にはこれらのスクリプトに対応する 1 対 1 の機能マッピングはありませんが、v3 の 「S2I ツール」には「カスタム可能なスクリプト」を指定の URL またはソースリポジトリーの .s2i/bin ディレクトリーに追加するオプションがあります。

OpenShift バージョン 3 (v3) には、イメージをビルドしてからレジストリーにプッシュするまでのイメージの基本的なテストを実行する「post-build hook」があります。「デプロイメントフック」はデプロイメント構成で設定されます。

v2 では、通常 action_hooks は環境変数を設定するために使用されます。v2 では、環境変数は以下のように渡される必要があります。

oc new-app <source-url> -e ENV_VAR=env_var

$ oc new-app <source-url> -e ENV_VAR=env_varまたは以下を実行します。

oc new-app <template-name> -p ENV_VAR=env_var

$ oc new-app <template-name> -p ENV_VAR=env_varまたは、以下を使用して環境変数を追加し、変更することができます。

oc set env dc/<name-of-dc> ENV_VAR1=env_var1 ENV_VAR2=env_var2’

$ oc set env dc/<name-of-dc>

ENV_VAR1=env_var1 ENV_VAR2=env_var2’6.7. S2I ツール

6.7.1. 概要

「Source-to-Image (S2I) ツール」は、アプリケーションのソースコードをコンテナーイメージに挿入します。最終成果物として、ビルダーイメージとビルド済みのソースコードが組み込まれた実行準備のできたコンテナーイメージが新たに作成されます。S2I ツールは、OpenShift Container Platform がなくても、「リポジトリー」から、ローカルマシンにインストールできます。

S2I ツールは、OpenShift Container Platform で使用する前にアプリケーションとイメージをローカルでテストし、検証するための非常に強力なツールです。

6.7.2. コンテナーイメージの作成

- アプリケーションに必要なビルダーイメージを特定します。Red Hat は、「Python、Ruby、Perl、PHP および Node.js」など各種の言語のビルダーイメージを複数提供しています。他のイメージは コミュニティースペース から取得できます。

S2I は、Git リポジトリーまたはローカルのファイルシステムのソースコードからイメージをビルドできます。ビルダーイメージおよびソースコードから新しいコンテナーイメージをビルドするには、以下を実行します。

s2i build <source-location> <builder-image-name> <output-image-name>

$ s2i build <source-location> <builder-image-name> <output-image-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記<source-location>には Git リポジトリーの URL、 またはローカルファイルシステムのソースコードのディレクトリーのいずれかを指定できます。Docker デーモンでビルドしたイメージをテストします。

docker run -d --name <new-name> -p <port-number>:<port-number> <output-image-name> curl localhost:<port-number>

$ docker run -d --name <new-name> -p <port-number>:<port-number> <output-image-name> $ curl localhost:<port-number>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 新しいイメージを「OpenShift レジストリー」にプッシュします。

ocコマンドを使用して、OpenShift レジストリーのイメージから新規アプリケーションを作成します。oc new-app <image-name>

$ oc new-app <image-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.8. サポートガイド

6.8.1. 概要

以下のトピックでは、OpenShift バージョン 2 (v2) および OpenShift バージョン 3 (v3) でサポート対象の言語、フレームワーク、データベース、マーカーについて説明します。

OpenShift Container Platform のお客様が使用する一般的な組み合わせに関する情報は、「OpenShift Container Platform tested integrations」を参照してください。

6.8.2. サポートされているデータベース

データベースアプリケーションのトピックの「サポート対象のデータベース」セクションを参照してください。

6.8.3. サポート言語

6.8.4. サポート対象のフレームワーク

| v2 | v3 |

|---|---|

|

Jenkins サーバー |

jenkins-persistent |

|

Drupal 7 | |

|

Ghost 0.7.5 | |

|

WordPress 4 | |

|

Ceylon | |

|

Go | |

|

MEAN |

6.8.5. サポート対象のマーカー

| v2 | v3 |

|---|---|

|

pip_install |

リポジトリーに requirements.txt が含まれる場合には、デフォルトで pip が呼び出されます。含まれていない場合に pip は使用されません。 |

| v2 | v3 |

|---|---|

|

disable_asset_compilation |

これは、buildconfig ストラテジー定義で |

| v2 | v3 |

|---|---|

|

enable_cpan_tests |

これは、「ビルド設定」で |

| v2 | v3 |

|---|---|

|

use_composer |

ソースリポジトリーの root ディレクトリーに composer.json が含まれる場合に、コンポーザーが常に使用されます。 |

| v2 | v3 |

|---|---|

|

NODEJS_VERSION |

該当なし |

|

use_npm |

アプリケーションの起動には、 |

| v2 | v3 |

|---|---|

|

enable_debugging |

このオプションは、デプロイメント設定で設定される |

|

skip_maven_build |

pom.xml がある場合には、maven が実行されます。 |

|

java7 |

該当なし |

|

java8 |

JavaEE は JDK8 を使用します。 |

| v2 | v3 |

|---|---|

|

enable_debugging |

該当なし |

| v2 | v3 |

|---|---|

|

force_clean_build |

v3 には同様の概念が使われています。buildconfig の noCache フィールドにより、コンテナービルドによる各層の再実行が強制的に実行されます。S2I ビルドでは、clean build を示す incremental フラグはデフォルトで false になっています。 |

|

hot_deploy | |

|

enable_public_server_status |

該当なし |

|

disable_auto_scaling |

自動スケーリングはデフォルトではオフになっていますが、「Pod auto-scaling」でオンにすることができます。 |

6.8.6. サポート対象の環境変数

第7章 チュートリアル

7.1. 概要

以下のトピックでは、OpenShift Container Platform でアプリケーションを稼働させる方法や、さまざまな言語とフレームワークについて説明します。

7.2. クイックスタートのテンプレート

7.2.1. 概要

クイックスタートは、OpenShift Container Platform で実行するアプリケーションの基本例です。クイックスタートはさまざまな言語やフレームワークが含まれており、サービスのセット、ビルド設定およびデプロイメント設定などで構成される「テンプレート」で定義されています。このテンプレートは、必要なイメージやソースリポジトリーを参照して、アプリケーションをビルドし、デプロイします。

クイックスタートを試してみるには、テンプレートからアプリケーションを作成します。管理者がすでにこれらのテンプレートを OpenShift Container Platform クラスターにインストールしている可能性がありますが、その場合には、Web コンソールからこれを簡単に選択できます。テンプレートのアップロード、作成、変更に関する情報は、「テンプレート」のドキュメントを参照してください。

クイックスタートは、アプリケーションのソースコードを含むソースリポジトリーを参照します。クイックスタートをカスタマイズするには、リポジトリーをフォークし、テンプレートからアプリケーションを作成する時に、デフォルトのソースリポジトリー名をフォークしたリポジトリーに置き換えます。これにより、提供されたサンプルのソースではなく、独自のソースコードを使用してビルドが実行されます。ソースリポジトリーでコードを更新し、新しいビルドを起動して、デプロイされたアプリケーションで変更が反映されていることを確認できます。

7.2.2. Web フレームワーククイックスタートのテンプレート

以下のクイックスタートでは、指定のフレームワークおよび言語の基本アプリケーションを提供します。

CakePHP: PHP web フレームワーク (MySQL データベースを含む)

Dancer: Perl web フレームワーク (MySQL データベースを含む)

Django: Python web フレームワーク (PostgreSQL データベースを含む)

NodeJS: NodeJS web アプリケーション (MongoDB データベースを含む)

Rails: Ruby web フレームワーク (PostgreSQL データベースを含む)

7.3. Ruby on Rails

7.3.1. 概要

Ruby on Rails は Ruby で記述された一般的な Web フレームワークです。本ガイドでは、OpenShift Container Platform での Rails 4 の使用について説明します。

チュートリアル全体をチェックして、OpenShift Container Platform でアプリケーションを実行するために必要なすべての手順を概観することを強く推奨します。問題に直面した場合には、チュートリアル全体を振り返り、もう一度問題に対応してください。またチュートリアルは、実行済みの手順を確認し、すべての手順が適切に実行されていることを確認するのに役立ちます。

本ガイドでは、以下があることを前提としています。

- Ruby/Rails の基本知識

- Ruby 2.0.0+、Rubygems、Bundler のローカルにインストールされたバージョン

- Git の基本知識

- OpenShift Container Platform v3 の実行インスタンス

7.3.2. ローカルのワークステーション設定

まず、OpenShift Container Platform のインスタンスが実行されており、利用できることを確認します。OpenShift Container Platform を稼働させる方法については、「インストール方法」を確認してください。また、「oc CLI クライアントのインストール」が実行されており、コマンドがお使いのコマンドシェルから利用できることを確認し、CLI クライアントからメールとパスワードを使用して、「ログイン」できるようにします。

7.3.2.1. データベースの設定

Rails アプリケーションはほぼ常にデータベースと併用されます。ローカル開発の場合は、PostgreSQL データベースを選択してください。PostgreSQL データベースをインストール方法するには、以下を入力します。

sudo yum install -y postgresql postgresql-server postgresql-devel

$ sudo yum install -y postgresql postgresql-server postgresql-devel次に、以下のコマンドでデータベースを初期化する必要があります。

sudo postgresql-setup initdb

$ sudo postgresql-setup initdb

このコマンドで /var/lib/pgsql/data ディレクトリーが作成され、このディレクトリーにデータが保存されます。

以下を入力してデータベースを起動します。

sudo systemctl start postgresql.service

$ sudo systemctl start postgresql.service

データベースが実行されたら、rails ユーザーを作成します。

sudo -u postgres createuser -s rails

$ sudo -u postgres createuser -s rails作成をしたユーザーのパスワードは作成されていない点に留意してください。

7.3.3. アプリケーションの作成

Rails アプリケーションをゼロからビルドするには、Rails gem を先にインストールする必要があります。

gem install rails Successfully installed rails-4.2.0 1 gem installed

$ gem install rails

Successfully installed rails-4.2.0

1 gem installedRails gem のインストール後に、PostgreSQL をデータベースとして 指定して新規アプリケーションを作成します。

rails new rails-app --database=postgresql

$ rails new rails-app --database=postgresql次に、新規ディレクトリーに移動します。

cd rails-app

$ cd rails-app