This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.CI/CD

OpenShift Container Platform のビルド、パイプライン、および GitOps に関する情報

概要

第1章 OpenShift Container Platform CI/CD の概要

OpenShift Container Platform は、開発者向けのエンタープライズ対応の Kubernetes プラットフォームであり、組織は継続的インテグレーション (CI) や継続的デリバリー (CD) などの DevOps プラクティスを通じてアプリケーションデリバリープロセスを自動化できます。組織のニーズを満たすために、OpenShift Container Platform は以下の CI/CD ソリューションを提供します。

- OpenShift Builds

- OpenShift Pipeline

- OpenShift GitOps

1.1. OpenShift Builds

OpenShift Builds を使用すると、宣言型ビルドプロセスを使用してクラウドネイティブアプリを作成できます。BuildConfig オブジェクトの作成に使用する YAML ファイルでビルドプロセスを定義できます。この定義には、ビルドトリガー、入力パラメーター、ソースコードなどの属性が含まれます。デプロイされると、BuildConfig オブジェクトは通常、実行可能なイメージをビルドし、それをコンテナーイメージレジストリーにプッシュします。

OpenShift Builds は、ビルドストラテジーに対して以下の拡張可能なサポートを提供します。

- Docker ビルド

- Source-to-Image (S2I) ビルド

- カスタムビルド

詳細は、イメージビルドについて を参照してください。

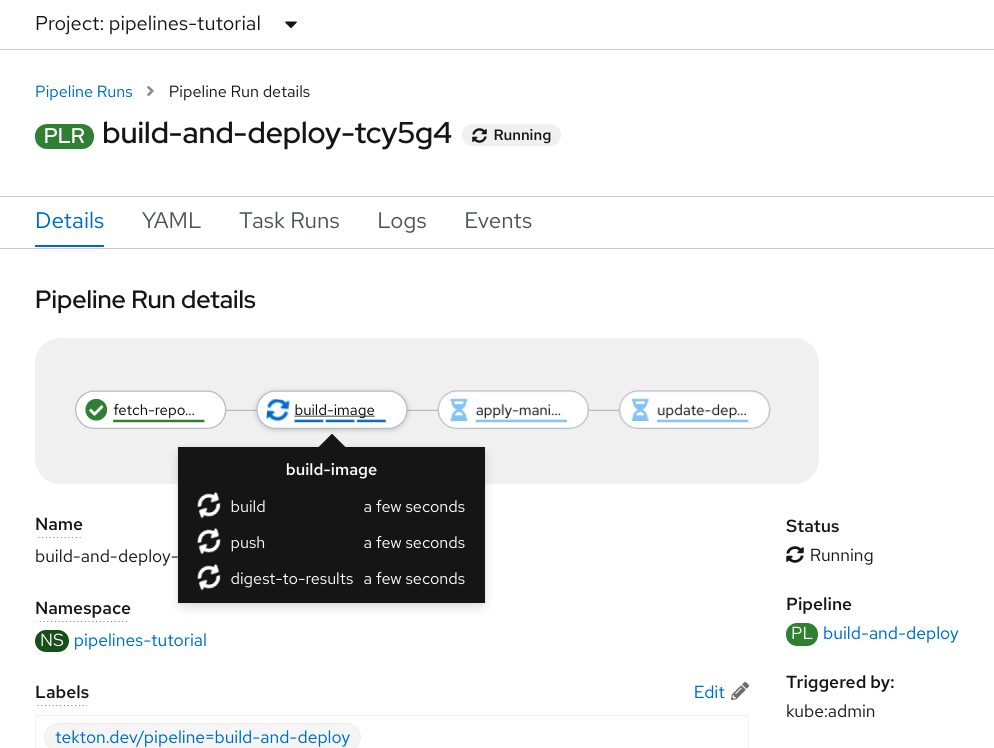

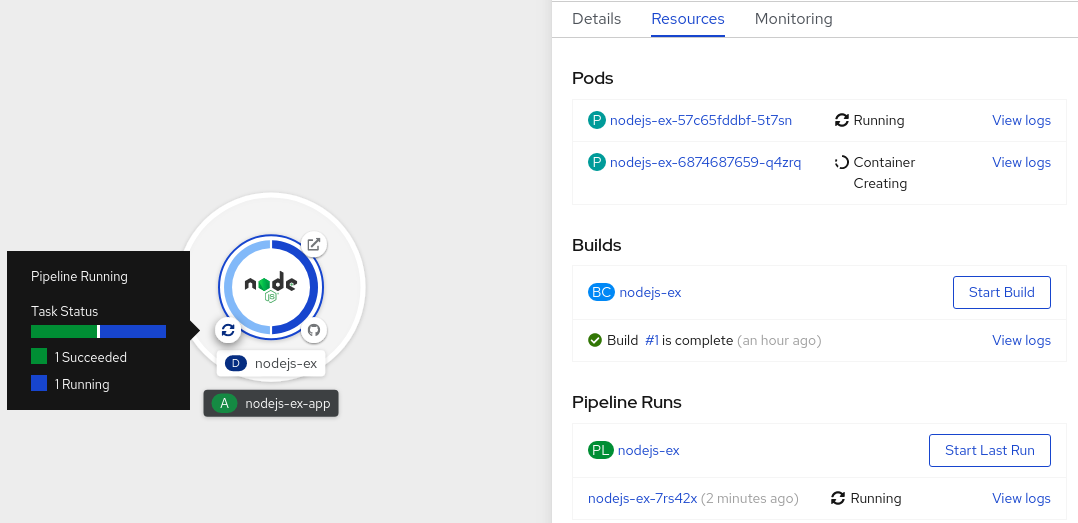

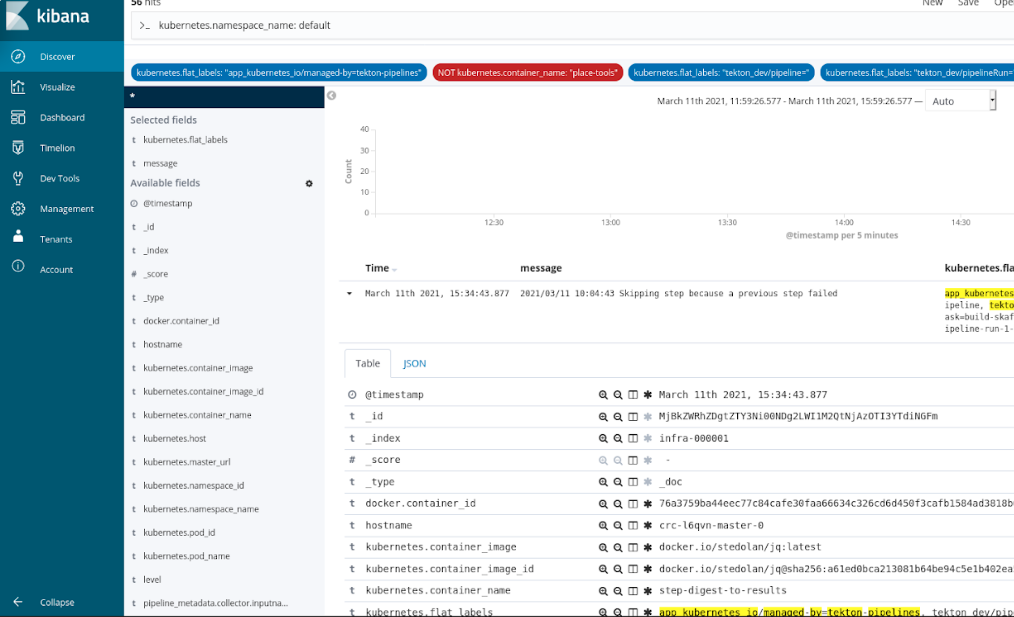

1.2. OpenShift Pipeline

OpenShift Pipelines は、Kubernetes ネイティブの CI/CD フレームワークを提供して、CI/CD パイプラインの各ステップを独自のコンテナーで設計および実行します。独立して拡張し、予測可能な結果を伴うオンデマンドパイプラインに対応できます。

詳細は、OpenShift Pipelines について を参照してください。

1.3. OpenShift GitOps

OpenShift GitOps は、宣言型 GitOps エンジンとして Argo CD を使用するオペレーターです。これにより、マルチクラスター OpenShift および Kubernetes インフラストラクチャー全体で GitOps ワークフローが可能になります。管理者は、OpenShift GitOps を使用して、クラスターおよび開発ライフサイクル全体で Kubernetes ベースのインフラストラクチャーとアプリケーションを一貫して設定およびデプロイできます。

OpenShift GitOps について を参照してください。

1.4. Jenkins

Jenkins は、アプリケーションとプロジェクトの構築、テスト、およびデプロイのプロセスを自動化します。OpenShift Developer Tools は、OpenShift Container Platform と直接統合する Jenkins イメージを提供します。Jenkins は、Samples Operator テンプレートまたは認定 Helm チャートを使用して OpenShift にデプロイできます。

第2章 ビルド

2.1. イメージビルドについて

2.1.1. ビルド

ビルドとは、入力パラメーターを結果として作成されるオブジェクトに変換するプロセスです。ほとんどの場合、このプロセスは入力パラメーターまたはソースコードを実行可能なイメージに変換するために使用されます。BuildConfig オブジェクトはビルドプロセス全体の定義です。

OpenShift Container Platform は、ビルドイメージからコンテナーを作成し、それらをコンテナーイメージレジストリーにプッシュして Kubernetes を使用します。

ビルドオブジェクトは共通の特性を共有します。これらには、ビルドの入力、ビルドプロセスの完了についての要件、ビルドプロセスのロギング、正常なビルドからのリリースのパブリッシュ、およびビルドの最終ステータスのパブリッシュが含まれます。ビルドはリソースの制限を利用し、CPU 使用、メモリー使用およびビルドまたは Pod の実行時間などのリソースの制限を指定します。

OpenShift Container Platform ビルドシステムは、ビルド API で指定される選択可能なタイプに基づくビルドストラテジーを幅広くサポートします。利用可能なビルドストラテジーは主に 3 つあります。

- Docker ビルド

- Source-to-Image (S2I) ビルド

- カスタムビルド

デフォルトで、docker ビルドおよび S2I ビルドがサポートされます。

ビルドの作成されるオブジェクトはこれを作成するために使用されるビルダーによって異なります。docker および S2I ビルドの場合、作成されるオブジェクトは実行可能なイメージです。カスタムビルドの場合、作成されるオブジェクトはビルダーイメージの作成者が指定するものになります。

さらに、パイプラインビルドストラテジーを使用して、高度なワークフローを実装することができます。

- 継続的インテグレーション

- 継続的デプロイメント

2.1.1.1. Docker ビルド

OpenShift Container Platform は Buildah を使用して Dockerfile からコンテナーイメージをビルドします。Dockerfile を使用したコンテナーイメージのビルドについての詳細は、Dockerfile リファレンスドキュメント を参照してください。

buildArgs 配列を使用して Docker ビルド引数を設定する場合は、Dockerfile リファレンスドキュメントの ARG および FROM の対話方法 について参照してください。

2.1.1.2. Source-to-Image ビルド

Source-to-Image (S2I) は再現可能なコンテナーイメージをビルドするためのツールです。これはアプリケーションソースをコンテナーイメージに挿入し、新規イメージをアセンブルして実行可能なイメージを生成します。新規イメージはベースイメージ、ビルダーおよびビルドされたソースを組み込み、buildah run コマンドで使用することができます。S2I は増分ビルドをサポートします。これは以前にダウンロードされた依存関係や、以前にビルドされたアーティファクトなどを再利用します。

2.1.1.3. カスタムビルド

カスタムビルドストラテジーにより、開発者はビルドプロセス全体を対象とする特定のビルダーイメージを定義できます。独自のビルダーイメージを使用することにより、ビルドプロセスをカスタマイズできます。

カスタムビルダーイメージは、RPM またはベースイメージの構築など、ビルドプロセスのロジックに組み込まれるプレーンなコンテナーイメージです。

カスタムビルドは高いレベルの権限で実行されるため、デフォルトではユーザーが利用することはできません。クラスター管理者のパーミッションを持つ信頼できるユーザーのみにカスタムビルドを実行するためのアクセスが付与される必要があります。

2.1.1.4. パイプラインビルド

パイプラインビルドストラテジーは OpenShift Container Platform 4 では非推奨になりました。同等の機能および改善機能は、Tekton をベースとする OpenShift Container Platform Pipeline にあります。

OpenShift Container Platform の Jenkins イメージは完全にサポートされており、ユーザーは Jenkins ユーザーのドキュメントに従ってジョブで jenkinsfile を定義するか、これをソースコントロール管理システムに保存します。

開発者は、パイプラインビルドストラテジーを利用して Jenkins パイプラインプラグインで使用できるように Jenkins パイプラインを定義することができます。このビルドについては、他のビルドタイプの場合と同様に OpenShift Container Platform での起動、モニタリング、管理が可能です。

パイプラインワークフローは、ビルド設定に直接組み込むか、Git リポジトリーに配置してビルド設定で参照して jenkinsfile で定義します。

2.2. ビルド設定について

以下のセクションでは、ビルド、ビルド設定の概念を定義し、利用できる主なビルドストラテジーの概要を示します。

2.2.1. BuildConfig

ビルド設定は、単一のビルド定義と新規ビルドを作成するタイミングについてのトリガーセットを記述します。ビルド設定は BuildConfig で定義されます。 BuildConfig は、新規インスタンスを作成するために API サーバーへの POST で使用可能な REST オブジェクトのことです。

ビルド設定または BuildConfig は、ビルドストラテジーと 1 つまたは複数のソースを特徴としています。ストラテジーはプロセスを決定し、ソースは入力内容を提供します。

OpenShift Container Platform を使用したアプリケーションの作成方法の選択に応じて Web コンソールまたは CLI のいずれを使用している場合でも、BuildConfig は通常自動的に作成され、いつでも編集できます。BuildConfig を設定する部分や利用可能なオプションを理解しておくと、後に設定を手動で変更する場合に役立ちます。

以下の BuildConfig の例では、コンテナーイメージのタグやソースコードが変更されるたびに新規ビルドが作成されます。

BuildConfig のオブジェクト定義

- 1

- この仕様は、

ruby-sample-buildという名前の新規のBuildConfigを作成します。 - 2

runPolicyフィールドは、このビルド設定に基づいて作成されたビルドを同時に実行できるかどうかを制御します。デフォルトの値はSerialです。 これは新規ビルドが同時にではなく、順番に実行されることを意味します。- 3

- 新規ビルドを作成するトリガーのリストを指定できます。

- 4

sourceセクションでは、ビルドのソースを定義します。ソースの種類は入力の主なソースを決定し、Git(コードのリポジトリーの場所を参照)、Dockerfile(インラインの Dockerfile からビルド) またはBinary(バイナリーペイロードを受け入れる) のいずれかとなっています。複数のソースを一度に指定できます。各ソースタイプの詳細については、ビルド入力の作成を参照してください。- 5

strategyセクションでは、ビルドの実行に使用するビルドストラテジーを記述します。ここではSource、DockerまたはCustomストラテジーを指定できます。上記の例では、Source-to-image (S2I) がアプリケーションのビルドに使用するruby-20-centos7コンテナーイメージを使用します。- 6

- コンテナーイメージが正常にビルドされた後に、これは

outputセクションで記述されているリポジトリーにプッシュされます。 - 7

postCommitセクションは、オプションのビルドフック を定義します。

2.3. ビルド入力の作成

以下のセクションでは、ビルド入力の概要、ビルドの動作に使用するソースコンテンツを提供するための入力の使用方法、およびビルド環境の使用およびシークレットの作成方法について説明します。

2.3.1. ビルド入力

ビルド入力は、ビルドが動作するために必要なソースコンテンツを提供します。以下のビルド入力を使用して OpenShift Cotainer Platform でソースを提供します。以下に優先される順で記載します。

- インラインの Dockerfile 定義

- 既存イメージから抽出したコンテンツ

- Git リポジトリー

- バイナリー (ローカル) 入力

- 入力シークレット

- 外部アーティファクト

複数の異なる入力を単一のビルドにまとめることができます。インラインの Dockerfile が優先されるため、別の入力で指定される Dockerfile という名前の他のファイルは上書きされます。バイナリー (ローカル) 入力および Git リポジトリーは併用できません。

入力シークレットは、ビルド時に使用される特定のリソースや認証情報をビルドで生成される最終アプリケーションイメージで使用不可にする必要がある場合や、シークレットリソースで定義される値を使用する必要がある場合に役立ちます。外部アーティファクトは、他のビルド入力タイプのいずれとしても利用できない別のファイルをプルする場合に使用できます。

ビルドを実行すると、以下が行われます。

- 作業ディレクトリーが作成され、すべての入力内容がその作業ディレクトリーに配置されます。たとえば、入力 Git リポジトリーのクローンはこの作業ディレクトリーに作成され、入力イメージから指定されたファイルはターゲットのパスを使用してこの作業ディレクトリーにコピーされます。

-

ビルドプロセスによりディレクトリーが

contextDirに変更されます (定義されている場合)。 - インライン Dockerfile がある場合は、現在のディレクトリーに書き込まれます。

-

現在の作業ディレクトリーにある内容が Dockerfile、カスタムビルダーのロジック、または

assembleスクリプトが参照するビルドプロセスに提供されます。つまり、ビルドではcontextDir内にない入力コンテンツは無視されます。

以下のソース定義の例には、複数の入力タイプと、入力タイプの統合方法の説明が含まれています。それぞれの入力タイプの定義方法に関する詳細は、各入力タイプについての個別のセクションを参照してください。

2.3.2. Dockerfile ソース

dockerfile の値が指定されると、このフィールドの内容は、dockerfile という名前のファイルとしてディスクに書き込まれます。これは、他の入力ソースが処理された後に実行されるので、入力ソースリポジトリーのルートディレクトリーに Dockerfile が含まれる場合は、これはこの内容で上書きされます。

ソースの定義は BuildConfig の spec セクションに含まれます。

source: dockerfile: "FROM centos:7\nRUN yum install -y httpd"

source:

dockerfile: "FROM centos:7\nRUN yum install -y httpd" - 1

dockerfileフィールドには、ビルドされるインライン Dockerfile が含まれます。

2.3.3. イメージソース

追加のファイルは、イメージを使用してビルドプロセスに渡すことができます。インプットイメージは From および To イメージターゲットが定義されるのと同じ方法で参照されます。つまり、コンテナーイメージとイメージストリームタグの両方を参照できます。イメージとの関連で、1 つまたは複数のパスのペアを指定して、ファイルまたはディレクトリーのパスを示し、イメージと宛先をコピーしてビルドコンテキストに配置する必要があります。

ソースパスは、指定したイメージ内の絶対パスで指定してください。宛先は、相対ディレクトリーパスでなければなりません。ビルド時に、イメージは読み込まれ、指定のファイルおよびディレクトリーはビルドプロセスのコンテキストディレクトリーにコピーされます。これは、ソースリポジトリーのコンテンツのクローンが作成されるディレクトリーと同じです。ソースパスの末尾は /. であり、ディレクトリーのコンテンツがコピーされますが、ディレクトリー自体は宛先で作成されません。

イメージの入力は、BuildConfig の source の定義で指定します。

- 1

- 1 つ以上のインプットイメージおよびファイルの配列

- 2

- コピーされるファイルが含まれるイメージへの参照

- 3

- ソース/宛先パスの配列

- 4

- ビルドプロセスで対象のファイルにアクセス可能なビルドルートへの相対パス

- 5

- 参照イメージの中からコピーするファイルの場所

- 6

- 認証情報がインプットイメージにアクセスするのに必要な場合に提供されるオプションのシークレット注記

クラスターが

ImageContentSourcePolicyオブジェクトを使用してリポジトリーのミラーリングを設定する場合、ミラーリングされたレジストリーにグローバルプルシークレットのみを使用できます。プロジェクトにプルシークレットを追加することはできません。

オプションとして、インプットイメージにプルシークレットが必要な場合、プルシークレットをビルドによって使用されるサービスアカウントにリンクできます。デフォルトで、ビルドは builder サービスアカウントを使用します。シークレットにインプットイメージをホストするリポジトリーに一致する認証情報が含まれる場合、プルシークレットはビルドに自動的に追加されます。プルシークレットをビルドで使用されるサービスアカウントにリンクするには、以下を実行します。

oc secrets link builder dockerhub

$ oc secrets link builder dockerhubこの機能は、カスタムストラテジーを使用するビルドについてサポートされません。

2.3.4. Git ソース

ソースコードは、指定されている場合は指定先の場所からフェッチされます。

インラインの Dockerfile を指定する場合は、これにより Git リポジトリーの contextDir 内にある Dockerfile が上書きされます。

ソースの定義は BuildConfig の spec セクションに含まれます。

- 1

gitフィールドには、ソースコードのリモート Git リポジトリーへの URI (Uniform Resource Identifier) が含まれます。特定の Git リファレンスをチェックアウトするには、refフィールドの値を指定する必要があります。SHA1 タグまたはブランチ名は、refとして有効です。refフィールドのデフォルト値はmasterです。- 2

contextDirフィールドでは、ビルドがアプリケーションのソースコードを検索する、ソースコードのリポジトリー内のデフォルトの場所を上書きできます。アプリケーションがサブディレクトリーに存在する場合には、このフィールドを使用してデフォルトの場所 (root フォルダー) を上書きすることができます。- 3

- オプションの

dockerfileフィールドがある場合は、Dockerfile を含む文字列を指定してください。 この文字列は、ソースリポジトリーに存在する可能性のある Dockerfile を上書きします。

ref フィールドにプル要求が記載されている場合には、システムは git fetch 操作を使用して FETCH_HEAD をチェックアウトします。

ref の値が指定されていない場合は、OpenShift Container Platform はシャロークローン (--depth=1) を実行します。この場合、デフォルトのブランチ (通常は master) での最新のコミットに関連するファイルのみがダウンロードされます。これにより、リポジトリーのダウンロード時間が短縮されます (詳細のコミット履歴はありません)。指定リポジトリーのデフォルトのブランチで完全な git clone を実行するには、ref をデフォルトのブランチ名に設定します (例: main)。

中間者 (MITM) TLS ハイジャックまたはプロキシーされた接続の再暗号化を実行するプロキシーを通過する Git クローンの操作は機能しません。

2.3.4.1. プロキシーの使用

プロキシーの使用によってのみ Git リポジトリーにアクセスできる場合は、使用するプロキシーをビルド設定の source セクションで定義できます。HTTP および HTTPS プロキシーの両方を設定できます。いずれのフィールドもオプションです。NoProxy フィールドで、プロキシーを実行しないドメインを指定することもできます。

実際に機能させるには、ソース URI で HTTP または HTTPS プロトコルを使用する必要があります。

パイプラインストラテジーのビルドの場合には、現在 Jenkins の Git プラグインに制約があるので、Git プラグインを使用する Git の操作では BuildConfig に定義された HTTP または HTTPS プロキシーは使用されません。Git プラグインは、Jenkins UI の Plugin Manager パネルで設定されたプロキシーのみを使用します。どのジョブであっても、Jenkins 内の Git のすべての対話にはこのプロキシーが使用されます。

2.3.4.2. ソースクローンのシークレット

ビルダー Pod には、ビルドのソースとして定義された Git リポジトリーへのアクセスが必要です。ソースクローンのシークレットは、ビルダー Pod に対し、プライベートリポジトリーや自己署名証明書または信頼されていない SSL 証明書が設定されたリポジトリーなどの通常アクセスできないリポジトリーへのアクセスを提供するために使用されます。

以下は、サポートされているソースクローンのシークレット設定です。

- .gitconfig ファイル

- Basic 認証

- SSH キー認証

- 信頼されている認証局

特定のニーズに対応するために、これらの設定の組み合わせを使用することもできます。

2.3.4.2.1. ソースクローンシークレットのビルド設定への自動追加

BuildConfig が作成されると、OpenShift Container Platform はソースクローンのシークレット参照を自動生成します。この動作により、追加の設定なしに、作成されるビルドが参照されるシークレットに保存された認証情報を自動的に使用できるようになり、リモート Git リポジトリーに対する認証が可能になります。

この機能を使用するには、Git リポジトリーの認証情報を含むシークレットが BuildConfig が後に作成される namespace になければなりません。このシークレットには、接頭辞 build.openshift.io/source-secret-match-uri- で開始するアノテーション 1 つ以上含まれている必要もあります。これらの各アノテーションの値には、以下で定義される URI (Uniform Resource Identifier) パターンを使用します。これは以下のように定義されます。ソースクローンのシークレット参照なしに BuildConfig が作成され、Git ソースの URI がシークレットのアノテーションの URI パターンと一致する場合に、OpenShift Container Platform はそのシークレットへの参照を BuildConfig に自動的に挿入します。

前提条件

URI パターンには以下を含める必要があります。

-

有効なスキーム:

*://、git://、http://、https://またはssh:// -

ホスト: *` または有効なホスト名、あるいは

*.が先頭に指定された IP アドレス -

パス:

/*または、/の後に*文字などの文字がオプションで後に続きます。

上記のいずれの場合でも、* 文字はワイルドカードと見なされます。

URI パターンは、RFC3986 に準拠する Git ソースの URI と一致する必要があります。URI パターンにユーザー名 (またはパスワード) のコンポーネントを含ないようにしてください。

たとえば、Git リポジトリーの URL に ssh://git@bitbucket.atlassian.com:7999/ATLASSIAN jira.git を使用する場合に、ソースのシークレットは、ssh://bitbucket.atlassian.com:7999/* として指定する必要があります (ssh://git@bitbucket.atlassian.com:7999/* ではありません)。

oc annotate secret mysecret \

'build.openshift.io/source-secret-match-uri-1=ssh://bitbucket.atlassian.com:7999/*'

$ oc annotate secret mysecret \

'build.openshift.io/source-secret-match-uri-1=ssh://bitbucket.atlassian.com:7999/*'手順

複数のシークレットが特定の BuildConfig の Git URI と一致する場合は、OpenShift Container Platform は一致する文字列が一番長いシークレットを選択します。これは、以下の例のように基本的な上書きを許可します。

以下の部分的な例では、ソースクローンのシークレットの一部が 2 つ表示されています。 1 つ目は、HTTPS がアクセスする mycorp.com ドメイン内のサーバーに一致しており、2 つ目は mydev1.mycorp.com および mydev2.mycorp.com のサーバーへのアクセスを上書きします。

以下のコマンドを使用して、

build.openshift.io/source-secret-match-uri-アノテーションを既存のシークレットに追加します。oc annotate secret mysecret \ 'build.openshift.io/source-secret-match-uri-1=https://*.mycorp.com/*'$ oc annotate secret mysecret \ 'build.openshift.io/source-secret-match-uri-1=https://*.mycorp.com/*'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.4.2.2. ソースクローンシークレットの手動による追加

ソースクローンのシークレットは、ビルド設定に手動で追加できます。 sourceSecret フィールドを BuildConfig 内の source セクションに追加してから、作成したシークレットの名前に設定して実行できます。この例では basicsecret です。

手順

oc set build-secret コマンドを使用して、既存のビルド設定にソースクローンのシークレットを設定することも可能です。

既存のビルド設定にソースクローンシークレットを設定するには、以下のコマンドを実行します。

oc set build-secret --source bc/sample-build basicsecret

$ oc set build-secret --source bc/sample-build basicsecretCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.4.2.3. .gitconfig ファイルからのシークレットの作成

アプリケーションのクローンが .gitconfig ファイルに依存する場合、そのファイルが含まれるシークレットを作成できます。これをビルダーサービスアカウントおよび BuildConfig に追加します。

手順

-

.gitconfigファイルからシークレットを作成するには、以下を実行します。

oc create secret generic <secret_name> --from-file=<path/to/.gitconfig>

$ oc create secret generic <secret_name> --from-file=<path/to/.gitconfig>

.gitconfig ファイルの http セクションが sslVerify=false に設定されている場合は、SSL 検証をオフにすることができます。

[http]

sslVerify=false

[http]

sslVerify=false2.3.4.2.4. セキュリティー保護された Git の .gitconfig ファイルからのシークレットの作成

Git サーバーが 2 方向の SSL、ユーザー名とパスワードでセキュリティー保護されている場合には、ソースビルドに証明書ファイルを追加して、.gitconfig ファイルに証明書ファイルへの参照を追加する必要があります。

前提条件

- Git 認証情報が必要です。

手順

ソースビルドに証明書ファイルを追加して、.gitconfig ファイルに証明書ファイルへの参照を追加します。

-

client.crt、cacert.crt、およびclient.keyファイルをアプリケーションソースコードの/var/run/secrets/openshift.io/source/フォルダーに追加します。 サーバーの

.gitconfigファイルに、以下のように[http]セクションを追加します。cat .gitconfig

# cat .gitconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

パスワードを再度入力しなくてもよいように、ビルドに Source-to-Image (S2I) イメージを指定するようにしてください。ただし、リポジトリーをクローンできない場合には、ビルドをプロモートするためにユーザー名とパスワードを指定する必要があります。

2.3.4.2.5. ソースコードの基本的な認証からのシークレットの作成

Basic 認証では、SCM (software configuration management) サーバーに対して認証する場合に --username と --password の組み合わせ、またはトークンが必要です。

前提条件

- プライベートリポジトリーにアクセスするためのユーザー名およびパスワード。

手順

シークレットを先に作成してから、プライベートリポジトリーにアクセスするために

--usernameおよび--passwordを使用してください。oc create secret generic <secret_name> \ --from-literal=username=<user_name> \ --from-literal=password=<password> \ --type=kubernetes.io/basic-auth$ oc create secret generic <secret_name> \ --from-literal=username=<user_name> \ --from-literal=password=<password> \ --type=kubernetes.io/basic-authCopy to Clipboard Copied! Toggle word wrap Toggle overflow トークンで Basic 認証のシークレットを作成します。

oc create secret generic <secret_name> \ --from-literal=password=<token> \ --type=kubernetes.io/basic-auth$ oc create secret generic <secret_name> \ --from-literal=password=<token> \ --type=kubernetes.io/basic-authCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.4.2.6. ソースコードの SSH キー認証からのシークレットの作成

SSH キーベースの認証では、プライベート SSH キーが必要です。

リポジトリーのキーは通常 $HOME/.ssh/ ディレクトリーにあり、デフォルトで id_dsa.pub、id_ecdsa.pub、id_ed25519.pub、または id_rsa.pub という名前が付けられています。

手順

SSH キーの認証情報を生成します。

ssh-keygen -t ed25519 -C "your_email@example.com"

$ ssh-keygen -t ed25519 -C "your_email@example.com"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記SSH キーのパスフレーズを作成すると、OpenShift Container Platform でビルドができなくなります。パスフレーズを求めるプロンプトが出されても、ブランクのままにします。

パブリックキーと、それに対応するプライベートキーのファイルが 2 つ作成されます (

id_dsa、id_ecdsa、id_ed25519またはid_rsaのいずれか)。これらが両方設定されたら、パブリックキーのアップロード方法についてソースコントロール管理 (SCM) システムのマニュアルを参照してください。プライベートキーは、プライベートリポジトリーにアクセスするために使用されます。SSH キーを使用してプライベートリポジトリーにアクセスする前に、シークレットを作成します。

oc create secret generic <secret_name> \ --from-file=ssh-privatekey=<path/to/ssh/private/key> \ --from-file=<path/to/known_hosts> \ --type=kubernetes.io/ssh-auth$ oc create secret generic <secret_name> \ --from-file=ssh-privatekey=<path/to/ssh/private/key> \ --from-file=<path/to/known_hosts> \1 --type=kubernetes.io/ssh-authCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- オプション: このフィールドを追加すると、厳密なサーバーホストキーチェックが有効になります。

警告シークレットの作成中に

known_hostsファイルをスキップすると、ビルドが中間者 (MITM) 攻撃を受ける可能性があります。注記know_hostsファイルにソースコードのホストのエントリーが含まれていることを確認してください。

2.3.4.2.7. ソースコードの信頼されている認証局からのシークレットの作成

Git clone の操作時に信頼される TLS (Transport Layer Security) 認証局 (CA) のセットは OpenShift Container Platform インフラストラクチャーイメージにビルドされます。Git サーバーが自己署名の証明書を使用するか、イメージで信頼されていない認証局によって署名された証明書を使用する場合には、その証明書が含まれるシークレットを作成するか、TLS 検証を無効にしてください。

CA 証明書のシークレットを作成した場合に、OpenShift Container Platform はその証明書を使用して、Git clone 操作時に Git サーバーにアクセスします。存在する TLS 証明書をどれでも受け入れてしまう Git の SSL 検証の無効化に比べ、この方法を使用するとセキュリティーレベルが高くなります。

手順

CA 証明書ファイルでシークレットを作成します。

CA が中間認証局を使用する場合には、

ca.crtファイルにすべての CA の証明書を統合します。以下のコマンドを入力します。cat intermediateCA.crt intermediateCA.crt rootCA.crt > ca.crt

$ cat intermediateCA.crt intermediateCA.crt rootCA.crt > ca.crtCopy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットを作成します。

oc create secret generic mycert --from-file=ca.crt=</path/to/file>

$ oc create secret generic mycert --from-file=ca.crt=</path/to/file>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

ca.crtというキーの名前を使用する必要があります。

2.3.4.2.8. ソースシークレットの組み合わせ

特定のニーズに対応するために上記の方法を組み合わせてソースクローンのシークレットを作成することができます。

2.3.4.2.8.1. .gitconfig ファイルでの SSH ベースの認証シークレットの作成

SSH ベースの認証シークレットと .gitconfig ファイルなど、特定のニーズに応じてソースクローンシークレットを作成するための複数の異なる方法を組み合わせることができます。

前提条件

- SSH 認証

- .gitconfig ファイル

手順

.gitconfigファイルを使用して SSH ベースの認証シークレットを作成するには、以下を実行します。oc create secret generic <secret_name> \ --from-file=ssh-privatekey=<path/to/ssh/private/key> \ --from-file=<path/to/.gitconfig> \ --type=kubernetes.io/ssh-auth$ oc create secret generic <secret_name> \ --from-file=ssh-privatekey=<path/to/ssh/private/key> \ --from-file=<path/to/.gitconfig> \ --type=kubernetes.io/ssh-authCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.4.2.8.2. .gitconfig ファイルと CA 証明書を組み合わせるシークレットの作成

.gitconfig ファイルおよび認証局 (CA) 証明書を組み合わせるシークレットなど、特定のニーズに応じてソースクローンシークレットを作成するための複数の異なる方法を組み合わせることができます。

前提条件

- .gitconfig ファイル

- CA 証明書

手順

.gitconfigファイルと CA 証明書を組み合わせてシークレットを作成するには、以下を実行します。oc create secret generic <secret_name> \ --from-file=ca.crt=<path/to/certificate> \ --from-file=<path/to/.gitconfig>$ oc create secret generic <secret_name> \ --from-file=ca.crt=<path/to/certificate> \ --from-file=<path/to/.gitconfig>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.4.2.8.3. CA 証明書ファイルを使用した Basic 認証のシークレットの作成

Basic 認証および CA (certificate authority) 証明書を組み合わせるシークレットなど、特定のニーズに応じてソースクローンシークレットを作成するための複数の異なる方法を組み合わせることができます。

前提条件

- Basic 認証の認証情報

- CA 証明書

手順

CA 証明書ファイルを使用して Basic 認証のシークレットを作成し、以下を実行します。

oc create secret generic <secret_name> \ --from-literal=username=<user_name> \ --from-literal=password=<password> \ --from-file=ca-cert=</path/to/file> \ --type=kubernetes.io/basic-auth$ oc create secret generic <secret_name> \ --from-literal=username=<user_name> \ --from-literal=password=<password> \ --from-file=ca-cert=</path/to/file> \ --type=kubernetes.io/basic-authCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.4.2.8.4. .gitconfig ファイルを使用した Basic 認証シークレットの作成

Basic 認証および .gitconfig ファイルを組み合わせるシークレットなど、特定のニーズに応じてソースクローンシークレットを作成するための複数の異なる方法を組み合わせることができます。

前提条件

- Basic 認証の認証情報

-

.gitconfigファイル

手順

.gitconfigファイルで Basic 認証のシークレットを作成するには、以下を実行します。oc create secret generic <secret_name> \ --from-literal=username=<user_name> \ --from-literal=password=<password> \ --from-file=</path/to/.gitconfig> \ --type=kubernetes.io/basic-auth$ oc create secret generic <secret_name> \ --from-literal=username=<user_name> \ --from-literal=password=<password> \ --from-file=</path/to/.gitconfig> \ --type=kubernetes.io/basic-authCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.4.2.8.5. .gitconfig ファイルと CA 証明書を使用した Basic 認証シークレットの作成

Basic 認証、.gitconfig ファイルおよび CA 証明書を組み合わせるシークレットなど、特定のニーズに応じてソースクローンシークレットを作成するための複数の異なる方法を組み合わせることができます。

前提条件

- Basic 認証の認証情報

-

.gitconfigファイル - CA 証明書

手順

.gitconfigファイルと CA 証明書ファイルを合わせて Basic 認証シークレットを作成するには、以下を実行します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.5. バイナリー (ローカル) ソース

ローカルのファイルシステムからビルダーにコンテンツをストリーミングすることは、Binary タイプのビルドと呼ばれています。このビルドについての BuildConfig.spec.source.type の対応する値は Binary です。

このソースタイプは、oc start-build のみをベースとして使用される点で独特なタイプです。

バイナリータイプのビルドでは、ローカルファイルシステムからコンテンツをストリーミングする必要があります。そのため、バイナリータイプのビルドを自動的にトリガーすること (例: イメージの変更トリガーなど) はできません。これは、バイナリーファイルを提供することができないためです。同様に、Web コンソールからバイナリータイプのビルドを起動することはできません。

バイナリービルドを使用するには、以下のオプションのいずれかを指定して oc start-build を呼び出します。

-

--from-file: 指定したファイルのコンテンツはバイナリーストリームとしてビルダーに送信されます。ファイルに URL を指定することもできます。次に、ビルダーはそのデータをビルドコンテキストの上に、同じ名前のファイルに保存します。 -

--from-dirおよび--from-repo: コンテンツはアーカイブされて、バイナリーストリームとしてバイナリーに送信されます。次に、ビルダーはビルドコンテキストディレクトリー内にアーカイブのコンテンツをデプロイメントします。--from-dirを使用して、デプロイメントされるアーカイブに URL を指定することもできます。 -

--from-archive: 指定したアーカイブはビルダーに送信され、ビルドコンテキストディレクトリーにデプロイメントされます。このオプションは--from-dirと同様に動作しますが、このオプションの引数がディレクトリーの場合には常にアーカイブがホストに最初に作成されます。

上記のそれぞれの例では、以下のようになります。

-

BuildConfigにBinaryのソースタイプが定義されている場合には、これは事実上無視され、クライアントが送信する内容に置き換えられます。 -

BuildConfigにGitのソースタイプが定義されている場合には、BinaryとGitは併用できないので、動的に無効にされます。 この場合、ビルダーに渡されるバイナリーストリームのデータが優先されます。

ファイル名ではなく、HTTP または HTTPS スキーマを使用する URL を --from-file や --from-archive に渡すことができます。--from-file で URL を指定すると、ビルダーイメージのファイル名は Web サーバーが送信する Content-Disposition ヘッダーか、ヘッダーがない場合には URL パスの最後のコンポーネントによって決定されます。認証形式はどれもサポートされておらず、カスタムの TLS 証明書を使用したり、証明書の検証を無効にしたりできません。

oc new-build --binary=true を使用すると、バイナリービルドに関連する制約が実施されるようになります。作成される BuildConfig のソースタイプは Binary になります。 つまり、この BuildConfig のビルドを実行するための唯一の有効な方法は、--from オプションのいずれかを指定して oc start-build を使用し、必須のバイナリーデータを提供する方法になります。

Dockerfile および contextDir のソースオプションは、バイナリービルドに関して特別な意味を持ちます。

Dockerfile はバイナリービルドソースと合わせて使用できます。Ddockerfile を使用し、バイナリーストリームがアーカイブの場合には、そのコンテンツはアーカイブにある Dockerfile の代わりとして機能します。Dockerfile が --from-file の引数と合わせて使用されている場合には、ファイルの引数は Dockerfile となり、Dockerfile の値はバイナリーストリームの値に置き換わります。

バイナリーストリームがデプロイメントされたアーカイブのコンテンツをカプセル化する場合には、contextDir フィールドの値はアーカイブ内のサブディレクトリーと見なされます。 有効な場合には、ビルド前にビルダーがサブディレクトリーに切り替わります。

2.3.6. 入力シークレットおよび設定マップ

入力シークレットおよび設定マップのコンテンツがビルドの出力コンテナーイメージに表示されないようにするには、Docker build と source-to-image build ストラテジーでビルドボリュームを使用します。

シナリオによっては、ビルド操作で、依存するリソースにアクセスするための認証情報や他の設定データが必要になる場合がありますが、この情報をソースコントロールに配置するのは適切ではありません。この場合は、入力シークレットおよび入力設定マップを定義することができます。

たとえば、Maven を使用して Java アプリケーションをビルドする場合、プライベートキーを使用してアクセスされる Maven Central または JCenter のプライベートミラーをセットアップできます。そのプライベートミラーからライブラリーをダウンロードするには、以下を指定する必要があります。

-

ミラーの URL および接続の設定が含まれる

settings.xmlファイル。 -

~/.ssh/id_rsaなどの、設定ファイルで参照されるプライベートキー。

セキュリティー上の理由により、認証情報はアプリケーションイメージで公開しないでください。

以下の例は Java アプリケーションについて説明していますが、/etc/ssl/certs ディレクトリー、API キーまたはトークン、ラインセンスファイルなどに SSL 証明書を追加する場合に同じ方法を使用できます。

2.3.6.1. シークレットの概要

Secret オブジェクトタイプはパスワード、OpenShift Container Platform クライアント設定ファイル、dockercfg ファイル、プライベートソースリポジトリーの認証情報などの機密情報を保持するメカニズムを提供します。シークレットは機密内容を Pod から切り離します。シークレットはボリュームプラグインを使用してコンテナーにマウントすることも、システムが Pod の代わりにシークレットを使用して各種アクションを実行することもできます。

YAML シークレットオブジェクト定義

- 1

- シークレットにキー名および値の構造を示しています。

- 2

dataフィールドでキーに使用できる形式は、Kubernetes identifiers glossary のDNS_SUBDOMAIN値のガイドラインに従う必要があります。- 3

dataマップのキーに関連付けられる値は base64 でエンコーディングされている必要があります。- 4

stringDataマップのエントリーが base64 に変換され、このエントリーは自動的にdataマップに移動します。このフィールドは書き込み専用です。値はdataフィールドによってのみ返されます。- 5

stringDataマップのキーに関連付けられた値は単純なテキスト文字列で設定されます。

2.3.6.1.1. シークレットのプロパティー

キーのプロパティーには以下が含まれます。

- シークレットデータはその定義とは別に参照できます。

- シークレットデータのボリュームは一時ファイルストレージ機能 (tmpfs) でサポートされ、ノードで保存されることはありません。

- シークレットデータは namespace 内で共有できます。

2.3.6.1.2. シークレットの種類

type フィールドの値で、シークレットのキー名と値の構造を指定します。このタイプを使用して、シークレットオブジェクトにユーザー名とキーの配置を実行できます。検証の必要がない場合には、デフォルト設定の opaque タイプを使用してください。

以下のタイプから 1 つ指定して、サーバー側で最小限の検証をトリガーし、シークレットデータに固有のキー名が存在することを確認します。

-

kubernetes.io/service-account-token。サービスアカウントトークンを使用します。 -

kubernetes.io/dockercfg.必須の Docker 認証には.dockercfgファイルを使用します。 -

kubernetes.io/dockerconfigjson.必須の Docker 認証には.docker/config.jsonファイルを使用します。 -

kubernetes.io/basic-auth.Basic 認証で使用します。 -

kubernetes.io/ssh-auth.SSH キー認証で使用します。 -

kubernetes.io/tls.TLS 認証局で使用します。

検証の必要がない場合には type= Opaque と指定します。これは、シークレットがキー名または値の規則に準拠しないという意味です。opaque シークレットでは、任意の値を含む、体系化されていない key:value ペアも利用できます。

example.com/my-secret-type などの他の任意のタイプを指定できます。これらのタイプはサーバー側では実行されませんが、シークレットの作成者がその種類のキー/値の要件に従う意図があることを示します。

2.3.6.1.3. シークレットの更新

シークレットの値を変更する場合、すでに実行されている Pod で使用される値は動的に変更されません。シークレットを変更するには、元の Pod を削除してから新規の Pod を作成する必要があります (同じ PodSpec を使用する場合があります)。

シークレットの更新は、新規コンテナーイメージのデプロイと同じワークフローで実行されます。kubectl rolling-update コマンドを使用できます。

シークレットの resourceVersion 値は参照時に指定されません。したがって、シークレットが Pod の起動と同じタイミングで更新される場合、Pod に使用されるシークレットのバージョンは定義されません。

現時点で、Pod の作成時に使用されるシークレットオブジェクトのリソースバージョンを確認することはできません。コントローラーが古い resourceVersion を使用して Pod を再起動できるように、Pod がこの情報を報告できるようにすることが予定されています。それまでは既存シークレットのデータを更新せずに別の名前で新規のシークレットを作成します。

2.3.6.2. シークレットの作成

シークレットに依存する Pod を作成する前に、シークレットを作成する必要があります。

シークレットの作成時に以下を実行します。

- シークレットデータでシークレットオブジェクトを作成します。

- Pod のサービスアカウントをシークレットの参照を許可するように更新します。

-

シークレットを環境変数またはファイルとして使用する Pod を作成します (

secretボリュームを使用)。

手順

作成コマンドを使用して JSON または YAML ファイルのシークレットオブジェクトを作成できます。

oc create -f <filename>

$ oc create -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow たとえば、ローカルの

.docker/config.jsonファイルからシークレットを作成できます。oc create secret generic dockerhub \ --from-file=.dockerconfigjson=<path/to/.docker/config.json> \ --type=kubernetes.io/dockerconfigjson$ oc create secret generic dockerhub \ --from-file=.dockerconfigjson=<path/to/.docker/config.json> \ --type=kubernetes.io/dockerconfigjsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドにより、

dockerhubという名前のシークレットの JSON 仕様が生成され、オブジェクトが作成されます。YAML の不透明なシークレットオブジェクトの定義

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- opaque シークレットを指定します。

Docker 設定の JSON ファイルシークレットオブジェクトの定義

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.6.3. シークレットの使用

シークレットの作成後に、Pod を作成してシークレットを参照し、ログを取得し、Pod を削除することができます。

手順

シークレットを参照する Pod を作成します。

oc create -f <your_yaml_file>.yaml

$ oc create -f <your_yaml_file>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ログを取得します。

oc logs secret-example-pod

$ oc logs secret-example-podCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod を削除します。

oc delete pod secret-example-pod

$ oc delete pod secret-example-podCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.6.4. 入力シークレットおよび設定マップの追加

認証情報およびその他の設定データをソース管理に配置せずにビルドに提供するには、入力シークレットおよび入力設定マップを定義します。

シナリオによっては、ビルド操作で、依存するリソースにアクセスするための認証情報や他の設定データが必要になる場合があります。この情報をソース管理に配置せずに利用可能にするには、入力シークレットおよび入力設定マップを定義します。

手順

既存の BuildConfig オブジェクトに入力シークレットおよび/または設定マップを追加するには、以下を行います。

ConfigMapオブジェクトがない場合はこれを作成します。oc create configmap settings-mvn \ --from-file=settings.xml=<path/to/settings.xml>$ oc create configmap settings-mvn \ --from-file=settings.xml=<path/to/settings.xml>Copy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、

settings-mvnという名前の新しい設定マップが作成されます。これには、settings.xmlファイルのプレーンテキストのコンテンツが含まれます。ヒントまたは、以下の YAML を適用して設定マップを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Secretオブジェクトがない場合はこれを作成します。oc create secret generic secret-mvn \ --from-file=ssh-privatekey=<path/to/.ssh/id_rsa> --type=kubernetes.io/ssh-auth$ oc create secret generic secret-mvn \ --from-file=ssh-privatekey=<path/to/.ssh/id_rsa> --type=kubernetes.io/ssh-authCopy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、

secret-mvnという名前の新規シークレットが作成されます。 これには、id_rsaプライベートキーの base64 でエンコードされたコンテンツが含まれます。ヒントまたは、以下の YAML を適用して入力シークレットを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 設定マップおよびシークレットを既存の

BuildConfigオブジェクトのsourceセクションに追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

シークレットおよび設定マップを新規の BuildConfig オブジェクトに追加するには、以下のコマンドを実行します。

oc new-build \

openshift/wildfly-101-centos7~https://github.com/wildfly/quickstart.git \

--context-dir helloworld --build-secret “secret-mvn” \

--build-config-map "settings-mvn"

$ oc new-build \

openshift/wildfly-101-centos7~https://github.com/wildfly/quickstart.git \

--context-dir helloworld --build-secret “secret-mvn” \

--build-config-map "settings-mvn"

ビルド時に、settings.xml および id_rsa ファイルはソースコードが配置されているディレクトリーにコピーされます。OpenShift Container Platform S2I ビルダーイメージでは、これはイメージの作業ディレクトリーで、 Dockerfile の WORKDIR の指示を使用して設定されます。別のディレクトリーを指定するには、 destinationDir を定義に追加します。

新規の BuildConfig オブジェクトの作成時に、宛先のディレクトリーを指定することも可能です。

oc new-build \

openshift/wildfly-101-centos7~https://github.com/wildfly/quickstart.git \

--context-dir helloworld --build-secret “secret-mvn:.ssh” \

--build-config-map "settings-mvn:.m2"

$ oc new-build \

openshift/wildfly-101-centos7~https://github.com/wildfly/quickstart.git \

--context-dir helloworld --build-secret “secret-mvn:.ssh” \

--build-config-map "settings-mvn:.m2"

いずれの場合も、settings.xml ファイルがビルド環境の ./.m2 ディレクトリーに追加され、id_rsa キーは ./.ssh ディレクトリーに追加されます。

2.3.6.5. Source-to-Image ストラテジー

Source ストラテジーを使用すると、定義された入力シークレットはすべて、適切な destinationDir にコピーされます。destinationDir を空にすると、シークレットはビルダーイメージの作業ディレクトリーに配置されます。

destinationDir が相対パスの場合に同じルールが使用されます。シークレットは、イメージの作業ディレクトリーに相対的なパスに配置されます。destinationDir パスの最終ディレクトリーは、ビルダーイメージにない場合に作成されます。destinationDir の先行するすべてのディレクトリーは存在している必要があり、そうでない場合にはエラーが生じます。

入力シークレットは全ユーザーに書き込み権限が割り当てられた状態で追加され (0666 のパーミッション)、assemble スクリプトの実行後には、サイズが 0 になるように切り捨てられます。つまり、シークレットファイルは作成されたイメージ内に存在しますが、セキュリティーの理由で空になります。

入力設定マップは、assemble スクリプトの実行後に切り捨てられません。

2.3.6.6. Docker ストラテジー

docker ストラテジーを使用すると、Dockerfile で ADD および COPY の命令 を使用してコンテナーイメージに定義されたすべての入力シークレットを追加できます。

シークレットの destinationDir を指定しない場合は、ファイルは、Dockerfile が配置されているのと同じディレクトリーにコピーされます。相対パスを destinationDir として指定する場合は、シークレットは、Dockerfile の場所と相対的なディレクトリーにコピーされます。これにより、ビルド時に使用するコンテキストディレクトリーの一部として、Docker ビルド操作でシークレットファイルが利用できるようになります。

シークレットおよび設定マップデータを参照する Dockerfile の例

通常はシークレットがイメージから実行するコンテナーに置かれないように、入力シークレットを最終的なアプリケーションイメージから削除します。ただし、シークレットは追加される階層のイメージ自体に存在します。この削除は、Dockerfile の一部として組み込まれます。

入力シークレットおよび設定マップのコンテンツがビルド出力コンテナーイメージに表示されないようにして、この削除プロセスを完全に回避するには、代わりに Docker ビルドストラテジーで ビルドボリュームを使用 します。

2.3.6.7. カスタムストラテジー

Custom ストラテジーを使用する場合、定義された入力シークレットおよび設定マップはすべて、/var/run/secrets/openshift.io/build ディレクトリー内のビルダーコンテナーで入手できます。カスタムのビルドイメージは、これらのシークレットおよび設定マップを適切に使用する必要があります。Custom ストラテジーでは、Custom ストラテジーのオプションで説明されているようにシークレットを定義できます。

既存のストラテジーのシークレットと入力シークレットには違いはありません。ただし、ビルダーイメージはこれらを区別し、ビルドのユースケースに基づいてこれらを異なる方法で使用する場合があります。

入力シークレットは常に /var/run/secrets/openshift.io/build ディレクトリーにマウントされます。 そうでない場合には、ビルダーが完全なビルドオブジェクトを含む $BUILD 環境変数を解析できます。

レジストリーのプルシークレットが namespace とノードの両方に存在する場合、ビルドがデフォルトで namespace でのプルシークレットの使用に設定されます。

2.3.7. 外部アーティファクト

ソースリポジトリーにバイナリーファイルを保存することは推奨していません。そのため、ビルドプロセス中に追加のファイル (Java .jar の依存関係など) をプルするビルドを定義する必要がある場合があります。この方法は、使用するビルドストラテジーにより異なります。

Source ビルドストラテジーの場合は、assemble スクリプトに適切なシェルコマンドを設定する必要があります。

.s2i/bin/assemble ファイル

#!/bin/sh APP_VERSION=1.0 wget http://repository.example.com/app/app-$APP_VERSION.jar -O app.jar

#!/bin/sh

APP_VERSION=1.0

wget http://repository.example.com/app/app-$APP_VERSION.jar -O app.jar.s2i/bin/run ファイル

#!/bin/sh exec java -jar app.jar

#!/bin/sh

exec java -jar app.jar

Docker ビルドストラテジーの場合は、Dockerfile を変更して、RUN 命令 を指定してシェルコマンドを呼び出す必要があります。

Dockerfile の抜粋

実際には、ファイルの場所の環境変数を使用し、Dockerfile または assemble スクリプトを更新するのではなく、BuildConfig で定義した環境変数で、ダウンロードする特定のファイルをカスタマイズすることができます。

環境変数の定義には複数の方法があり、いずれかの方法を選択できます。

-

.s2i/environmentファイルの使用 (ソースビルドストラテジーのみ) -

BuildConfigでの設定 -

oc start-build --envを使用した明示的な指定 (手動でトリガーされるビルドのみが対象)

2.3.8. プライベートレジストリーでの docker 認証情報の使用

プライベートコンテナーレジストリーの有効な認証情報を指定して、.docker/config.json ファイルでビルドを提供できます。これにより、プライベートコンテナーイメージレジストリーにアウトプットイメージをプッシュしたり、認証を必要とするプライベートコンテナーイメージレジストリーからビルダーイメージをプルすることができます。

同じレジストリー内に、レジストリーパスに固有の認証情報を指定して、複数のリポジトリーに認証情報を指定できます。

OpenShift Container Platform コンテナーイメージレジストリーでは、OpenShift Container Platform が自動的にシークレットを生成するので、この作業は必要ありません。

デフォルトでは、.docker/config.json ファイルはホームディレクトリーにあり、以下の形式となっています。

複数のコンテナーイメージレジストリーを定義するか、同じレジストリーに複数のリポジトリーを定義することができます。または docker login コマンドを実行して、このファイルに認証エントリーを追加することも可能です。ファイルが存在しない場合には作成されます。

Kubernetes では Secret オブジェクトが提供され、これを使用して設定とパスワードを保存することができます。

前提条件

-

.docker/config.jsonファイルが必要です。

手順

ローカルの

.docker/config.jsonファイルからシークレットを作成します。oc create secret generic dockerhub \ --from-file=.dockerconfigjson=<path/to/.docker/config.json> \ --type=kubernetes.io/dockerconfigjson$ oc create secret generic dockerhub \ --from-file=.dockerconfigjson=<path/to/.docker/config.json> \ --type=kubernetes.io/dockerconfigjsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドにより、

dockerhubという名前のシークレットの JSON 仕様が生成され、オブジェクトが作成されます。pushSecretフィールドをBuildConfigのoutputセクションに追加し、作成したsecretの名前 (上記の例では、dockerhub) に設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc set build-secretコマンドを使用して、ビルド設定にプッシュするシークレットを設定します。oc set build-secret --push bc/sample-build dockerhub

$ oc set build-secret --push bc/sample-build dockerhubCopy to Clipboard Copied! Toggle word wrap Toggle overflow pushSecretフィールドを指定する代わりに、プッシュシークレットをビルドで使用されるサービスアカウントにリンクできます。デフォルトで、ビルドはbuilderサービスアカウントを使用します。シークレットにビルドのアウトプットイメージをホストするリポジトリーに一致する認証情報が含まれる場合、プッシュシークレットはビルドに自動的に追加されます。oc secrets link builder dockerhub

$ oc secrets link builder dockerhubCopy to Clipboard Copied! Toggle word wrap Toggle overflow ビルドストラテジー定義に含まれる

pullSecretを指定して、プライベートコンテナーイメージレジストリーからビルダーコンテナーイメージをプルします。Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc set build-secretコマンドを使用して、ビルド設定でプルシークレットを設定します。oc set build-secret --pull bc/sample-build dockerhub

$ oc set build-secret --pull bc/sample-build dockerhubCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記以下の例では、ソールビルドに

pullSecretを使用しますが、Docker とカスタムビルドにも該当します。pullSecretフィールドを指定する代わりに、プルシークレットをビルドで使用されるサービスアカウントにリンクできます。デフォルトで、ビルドはbuilderサービスアカウントを使用します。シークレットにビルドのインプットイメージをホストするリポジトリーに一致する認証情報が含まれる場合、プルシークレットはビルドに自動的に追加されます。pullSecretフィールドを指定する代わりに、プルシークレットをビルドで使用されるサービスアカウントにリンクするには、以下を実行します。oc secrets link builder dockerhub

$ oc secrets link builder dockerhubCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記この機能を使用するには、

fromイメージをBuildConfig仕様に指定する必要があります。oc new-buildまたはoc new-appで生成される Docker ストラテジービルドは、場合によってこれを実行しない場合があります。

2.3.9. ビルド環境

Pod 環境変数と同様に、ビルドの環境変数は Downward API を使用して他のリソースや変数の参照として定義できます。ただし、いくつかは例外があります。

oc set env コマンドで、BuildConfig に定義した環境変数を管理することも可能です。

参照はコンテナーの作成前に解決されるため、ビルド環境変数の valueFrom を使用したコンテナーリソースの参照はサポートされません。

2.3.9.1. 環境変数としてのビルドフィールドの使用

ビルドオブジェクトの情報は、値を取得するフィールドの JsonPath に、fieldPath 環境変数のソースを設定することで挿入できます。

Jenkins Pipeline ストラテジーは、環境変数の valueFrom 構文をサポートしません。

手順

値を取得するフィールドの

JsonPathに、fieldPath環境変数のソースを設定します。env: - name: FIELDREF_ENV valueFrom: fieldRef: fieldPath: metadata.nameenv: - name: FIELDREF_ENV valueFrom: fieldRef: fieldPath: metadata.nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.9.2. 環境変数としてのシークレットの使用

valueFrom 構文を使用して、シークレットからのキーの値を環境変数として利用できます。

この方法では、シークレットをビルド Pod コンソールの出力でプレーンテキストとして表示します。これを回避するには、代わりに入力シークレットおよび設定マップを使用します。

手順

シークレットを環境変数として使用するには、

valueFrom構文を設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.10. サービス提供証明書のシークレット

サービスが提供する証明書のシークレットは、追加設定なしの証明書を必要とする複雑なミドルウェアアプリケーションをサポートするように設計されています。これにはノードおよびマスターの管理者ツールで生成されるサーバー証明書と同じ設定が含まれます。

手順

サービスとの通信のセキュリティーを保護するには、クラスターが署名された提供証明書/キーペアを namespace のシークレットに生成できるようにします。

値をシークレットに使用する名前に設定し、

service.beta.openshift.io/serving-cert-secret-nameアノテーションをサービスに設定します。次に、

PodSpecはそのシークレットをマウントできます。これが利用可能な場合、Pod が実行されます。この証明書は内部サービス DNS 名、<service.name>.<service.namespace>.svcに適しています。証明書およびキーは PEM 形式であり、それぞれ

tls.crtおよびtls.keyに保存されます。証明書/キーのペアは有効期限に近づくと自動的に置換されます。シークレットのservice.beta.openshift.io/expiryアノテーションで RFC3339 形式の有効期限の日付を確認します。

ほとんどの場合、サービス DNS 名 <service.name>.<service.namespace>.svc は外部にルーティング可能ではありません。<service.name>.<service.namespace>.svc の主な使用方法として、クラスターまたはサービス間の通信用として、 re-encrypt ルートで使用されます。

他の Pod は Pod に自動的にマウントされる /var/run/secrets/kubernetes.io/serviceaccount/service-ca.crt ファイルの認証局 (CA) バンドルを使用して、クラスターで作成される証明書 (内部 DNS 名の場合にのみ署名される) を信頼できます。

この機能の署名アルゴリズムは x509.SHA256WithRSA です。ローテーションを手動で実行するには、生成されたシークレットを削除します。新規の証明書が作成されます。

2.3.11. シークレットの制限

シークレットを使用するには、Pod がシークレットを参照できる必要があります。シークレットは、以下の 3 つの方法で Pod で使用されます。

- コンテナーの環境変数を事前に設定するために使用される。

- 1 つ以上のコンテナーにマウントされるボリュームのファイルとして使用される。

- Pod のイメージをプルする際に kubelet によって使用される。

ボリュームタイプのシークレットは、ボリュームメカニズムを使用してデータをファイルとしてコンテナーに書き込みます。imagePullSecrets は、シークレットを namespace のすべての Pod に自動的に挿入するためにサービスアカウントを使用します。

テンプレートにシークレット定義が含まれる場合、テンプレートで指定のシークレットを使用できるようにするには、シークレットのボリュームソースを検証し、指定されるオブジェクト参照が Secret タイプのオブジェクトを実際に参照していることを確認できる必要があります。そのため、シークレットはこれに依存する Pod の作成前に作成されている必要があります。最も効果的な方法として、サービスアカウントを使用してシークレットを自動的に挿入することができます。

シークレット API オブジェクトは namespace にあります。それらは同じ namespace の Pod によってのみ参照されます。

個々のシークレットは 1MB のサイズに制限されます。これにより、apiserver および kubelet メモリーを使い切るような大規模なシークレットの作成を防ぐことができます。ただし、小規模なシークレットであってもそれらを数多く作成するとメモリーの消費につながります。

2.4. ビルド出力の管理

ビルド出力の概要およびビルド出力の管理方法についての説明については、以下のセクションを使用します。

2.4.1. ビルド出力

docker または Source-to-Image (S2I) ストラテジーを使用するビルドにより、新しいコンテナーイメージが作成されます。このイメージは、Build 仕様の output セクションで指定されているコンテナーイメージのレジストリーにプッシュされます。

出力の種類が ImageStreamTag の場合は、イメージが統合された OpenShift イメージレジストリーにプッシュされ、指定のイメージストリームにタグ付けされます。出力が DockerImage タイプの場合は、出力参照の名前が docker のプッシュ仕様として使用されます。この仕様にレジストリーが含まれる場合もありますが、レジストリーが指定されていない場合は、DockerHub にデフォルト設定されます。ビルド仕様の出力セクションが空の場合には、ビルドの最後にイメージはプッシュされません。

ImageStreamTag への出力

spec:

output:

to:

kind: "ImageStreamTag"

name: "sample-image:latest"

spec:

output:

to:

kind: "ImageStreamTag"

name: "sample-image:latest"docker のプッシュ仕様への出力

spec:

output:

to:

kind: "DockerImage"

name: "my-registry.mycompany.com:5000/myimages/myimage:tag"

spec:

output:

to:

kind: "DockerImage"

name: "my-registry.mycompany.com:5000/myimages/myimage:tag"2.4.2. アウトプットイメージの環境変数

docker および Source-to-Image (S2I) ストラテジービルドは、以下の環境変数をアウトプットイメージに設定します。

| 変数 | 説明 |

|---|---|

|

| ビルドの名前 |

|

| ビルドの namespace |

|

| ビルドのソース URL |

|

| ビルドで使用する Git 参照 |

|

| ビルドで使用するソースコミット |

また、S2I] または docker ストラテジーオプションなどで設定されたユーザー定義の環境変数も、アウトプットイメージの環境変数リストの一部になります。

2.4.3. アウトプットイメージのラベル

docker および Source-to-Image (S2I) ビルドは、以下のラベルをアウトプットイメージに設定します。

| ラベル | 説明 |

|---|---|

|

| ビルドで使用するソースコミットの作成者 |

|

| ビルドで使用するソースコミットの日付 |

|

| ビルドで使用するソースコミットのハッシュ |

|

| ビルドで使用するソースコミットのメッセージ |

|

| ソースに指定するブランチまたは参照 |

|

| ビルドのソース URL |

BuildConfig.spec.output.imageLabels フィールドを使用して、カスタムラベルのリストを指定することも可能です。 このラベルは、ビルド設定の各イメージビルドに適用されます。

ビルドイメージに適用されるカスタムラベル

2.5. ビルドストラテジーの使用

以下のセクションでは、主なサポートされているビルドストラテジー、およびそれらの使用方法を定義します。

2.5.1. Docker ビルド

OpenShift Container Platform は Buildah を使用して Dockerfile からコンテナーイメージをビルドします。Dockerfile を使用したコンテナーイメージのビルドについての詳細は、Dockerfile リファレンスドキュメント を参照してください。

buildArgs 配列を使用して Docker ビルド引数を設定する場合は、Dockerfile リファレンスドキュメントの ARG および FROM の対話方法 について参照してください。

2.5.1.1. Dockerfile FROM イメージの置き換え

Dockerfile の FROM 命令は、BuildConfig オブジェクトの from に置き換えられます。Dockerfile がマルチステージビルドを使用する場合、最後の FROM 命令のイメージを置き換えます。

手順

Dockerfile の FROM 命令は、BuildConfig の from に置き換えられます。

strategy:

dockerStrategy:

from:

kind: "ImageStreamTag"

name: "debian:latest"

strategy:

dockerStrategy:

from:

kind: "ImageStreamTag"

name: "debian:latest"2.5.1.2. Dockerfile パスの使用

デフォルトで、docker ビルドは、BuildConfig.spec.source.contextDir フィールドで指定されたコンテキストのルートに配置されている Dockerfile を使用します。

dockerfilePath フィールドでは、ビルドが異なるパスを使用して Dockerfile ファイルの場所 (BuildConfig.spec.source.contextDir フィールドへの相対パス) を特定できます。デフォルトの Dockerfile (例: MyDockerfile) とは異なるファイル名や、サブディレクトリーにある Dockerfile へのパス (例: dockerfiles/app1/Dockerfile) を設定できます。

手順

ビルドが Dockerfile を見つけるために異なるパスを使用できるように dockerfilePath フィールドを使用するには、以下を設定します。

strategy:

dockerStrategy:

dockerfilePath: dockerfiles/app1/Dockerfile

strategy:

dockerStrategy:

dockerfilePath: dockerfiles/app1/Dockerfile2.5.1.3. docker 環境変数の使用

環境変数を docker ビルドプロセスおよび結果として生成されるイメージで利用可能にするには、環境変数をビルド設定の dockerStrategy 定義に追加できます。

ここに定義した環境変数は、Dockerfile 内で後に参照できるよう単一の ENV Dockerfile 命令として FROM 命令の直後に挿入されます。

手順

変数はビルド時に定義され、アウトプットイメージに残るため、そのイメージを実行するコンテナーにも存在します。

たとえば、ビルドやランタイム時にカスタムの HTTP プロキシーを定義するには以下を設定します。

dockerStrategy:

...

env:

- name: "HTTP_PROXY"

value: "http://myproxy.net:5187/"

dockerStrategy:

...

env:

- name: "HTTP_PROXY"

value: "http://myproxy.net:5187/"

oc set env コマンドで、ビルド設定に定義した環境変数を管理することも可能です。

2.5.1.4. docker ビルド引数の追加

buildArgs 配列を使用して docker ビルド引数 を設定できます。ビルド引数は、ビルドの開始時に docker に渡されます。

Dockerfile リファレンスドキュメントの Understand how ARG and FROM interact を参照してください。

手順

docker ビルドの引数を設定するには、以下のように buildArgs 配列にエントリーを追加します。これは、BuildConfig オブジェクトの dockerStrategy 定義の中にあります。以下に例を示します。

dockerStrategy:

...

buildArgs:

- name: "foo"

value: "bar"

dockerStrategy:

...

buildArgs:

- name: "foo"

value: "bar"

name および value フィールドのみがサポートされます。valueFrom フィールドの設定は無視されます。

2.5.1.5. Docker ビルドによる層の非表示

Docker ビルドは通常、Dockerfile のそれぞれの命令を表す層を作成します。imageOptimizationPolicy を SkipLayers に設定することにより、すべての命令がベースイメージ上部の単一層にマージされます。

手順

imageOptimizationPolicyをSkipLayersに設定します。strategy: dockerStrategy: imageOptimizationPolicy: SkipLayersstrategy: dockerStrategy: imageOptimizationPolicy: SkipLayersCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.1.6. ビルドボリュームの使用

ビルドボリュームをマウントして、実行中のビルドに、アウトプットコンテナーイメージで永続化しない情報にアクセスできます。

ビルドボリュームは、ビルド時にビルド環境や設定が必要なリポジトリーの認証情報など、機密情報のみを提供します。ビルドボリュームは、データが出力コンテナーイメージに保持される ビルド入力 とは異なります。

実行中のビルドがデータを読み取るビルドボリュームのマウントポイントは機能的に pod volume mounts に似ています。

手順

BuildConfigオブジェクトのdockerStrategy定義で、ビルドボリュームをvolumes配列に追加します。以下に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1 5 9

- 必須。一意な名前

- 2 6 10

- 必須。マウントポイントの絶対パス。

..または:を含めないでください。こうすることで、ビルダーが生成した宛先パスと競合しなくなります。/opt/app-root/srcは、多くの Red Hat S2I 対応イメージのデフォルトのホームディレクトリーです。 - 3 7 11

- 必須。ソースのタイプは、

ConfigMap、Secret、またはCSI。 - 4 8

- 必須。ソースの名前。

- 12

- 必須。一時 CSI ボリュームを提供するドライバー。

- 13

- オプション: true の場合、ドライバーに読み取り専用ボリュームを提供するように指示します。

- 14

- オプション: 一時 CSI ボリュームのボリューム属性。サポートされる属性キーおよび値については、CSI ドライバーのドキュメントを参照してください。

共有リソース CSI ドライバーは、テクノロジープレビュー機能としてサポートされています。

2.5.2. Source-to-Image ビルド

Source-to-Image (S2I) は再現可能なコンテナーイメージをビルドするためのツールです。これはアプリケーションソースをコンテナーイメージに挿入し、新規イメージをアセンブルして実行可能なイメージを生成します。新規イメージはベースイメージ、ビルダーおよびビルドされたソースを組み込み、buildah run コマンドで使用することができます。S2I は増分ビルドをサポートします。これは以前にダウンロードされた依存関係や、以前にビルドされたアーティファクトなどを再利用します。

2.5.2.1. Source-to-Image (S2I) 増分ビルドの実行

Source-to-Image (S2I) は増分ビルドを実行できます。 つまり、以前にビルドされたイメージからアーティファクトが再利用されます。

手順

増分ビルドを作成するには、ストラテジー定義に以下の変更を加えてこれを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.2.2. Source-to-Image (S2I) ビルダーイメージスクリプトの上書き

ビルダーイメージによって提供される assemble、run、および save-artifacts Source-to-Image (S2I) スクリプトを上書きできます。

手順

ビルダーイメージによって提供される assemble、run、および save-artifacts S2I スクリプトを上書きするには、以下のいずれかを実行します。

-

アプリケーションのソースリポジトリーの

.s2i/binディレクトリーにassemble、run、 またはsave-artifactsスクリプトを指定します。 ストラテジー定義の一部として、スクリプトを含むディレクトリーの URL を指定します。以下に例を示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- このパスに、

run、assemble、およびsave-artifactsが追加されます。一部または全スクリプトがある場合、そのスクリプトが、イメージに指定された同じ名前のスクリプトの代わりに使用されます。

scripts URL にあるファイルは、ソースリポジトリーの .s2i/bin にあるファイルよりも優先されます。

2.5.2.3. Source-to-Image 環境変数

ソースビルドのプロセスと生成されるイメージで環境変数を利用できるようにする方法として、2 つの方法があります。2 種類 (環境ファイルおよび BuildConfig 環境の値の使用) あります。指定される変数は、ビルドプロセスでアウトプットイメージに表示されます。

2.5.2.3.1. Source-to-Image 環境ファイルの使用

ソースビルドでは、ソースリポジトリーの .s2i/environment ファイルに指定することで、アプリケーション内に環境の値 (1 行に 1 つ) を設定できます。このファイルに指定される環境変数は、ビルドプロセス時にアウトプットイメージに表示されます。

ソースリポジトリーに .s2i/environment ファイルを渡すと、Source-to-Image (S2I) はビルド時にこのファイルを読み取ります。これにより assemble スクリプトがこれらの変数を使用できるので、ビルドの動作をカスタマイズできます。

手順

たとえば、ビルド中の Rails アプリケーションのアセットコンパイルを無効にするには、以下を実行します。

-

DISABLE_ASSET_COMPILATION=trueを.s2i/environmentファイルに追加します。

ビルド以外に、指定の環境変数も実行中のアプリケーション自体で利用できます。たとえば、Rails アプリケーションが production ではなく development モードで起動できるようにするには、以下を実行します。

-

RAILS_ENV=developmentを.s2i/environmentファイルに追加します。

サポートされる環境変数の完全なリストについては、各イメージのイメージの使用についてのセクションを参照してください。

2.5.2.3.2. Source-to-Image ビルド設定環境の使用

環境変数をビルド設定の sourceStrategy 定義に追加できます。ここに定義されている環境変数は、assemble スクリプトの実行時に表示され、アウトプットイメージで定義されるので、run スクリプトやアプリケーションコードでも利用できるようになります。

手順

たとえば、Rails アプリケーションのアセットコンパイルを無効にするには、以下を実行します。

sourceStrategy: ... env: - name: "DISABLE_ASSET_COMPILATION" value: "true"sourceStrategy: ... env: - name: "DISABLE_ASSET_COMPILATION" value: "true"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.2.4. Source-to-Image ソースファイルを無視する

Source-to-Image (S2I) は .s2iignore ファイルをサポートします。これには、無視する必要のあるファイルパターンのリストが含まれます。このファイルには、無視すべきファイルパターンのリストが含まれます。 .s2iignore ファイルにあるパターンと一致する、さまざまな入力ソースで提供されるビルドの作業ディレクトリーにあるファイルは assemble スクリプトでは利用できません。

2.5.2.5. Source-to-Image によるソースコードからのイメージの作成

Source-to-Image (S2I) は、アプリケーションのソースコードを入力として取り、アセンブルされたアプリケーションを出力として実行する新規イメージを生成するイメージを簡単に作成できるようにするフレームワークです。

再生成可能なコンテナーイメージのビルドに S2I を使用する主な利点として、開発者の使い勝手の良さが挙げられます。ビルダーイメージの作成者は、イメージが最適な S2I パフォーマンスを実現できるように、ビルドプロセスと S2I スクリプトの基本的なコンセプト 2 点を理解する必要があります。

2.5.2.5.1. Source-to-Image ビルドプロセスについて

ビルドプロセスは、以下の 3 つの要素で設定されており、これら 3 つを組み合わせて最終的なコンテナーイメージが作成されます。

- ソース

- Source-to-Image (S2I) スクリプト

- ビルダーイメージ

S2I は、最初の FROM 命令として、ビルダーイメージで Dockerfile を生成します。S2I によって生成される Dockerfile は Buildah に渡されます。

2.5.2.5.2. Source-to-Image スクリプトの作成方法

Source-to-Image (S2I) スクリプトは、ビルダーイメージ内でスクリプトを実行できる限り、どのプログラム言語でも記述できます。S2I は assemble/run/save-artifacts スクリプトを提供する複数のオプションをサポートします。ビルドごとに、これらの場所はすべて、以下の順番にチェックされます。

- ビルド設定に指定されるスクリプト

-

アプリケーションソースの

.s2i/binディレクトリーにあるスクリプト -

io.openshift.s2i.scripts-urlラベルを含むデフォルトの URL にあるスクリプト

イメージで指定した io.openshift.s2i.scripts-url ラベルも、ビルド設定で指定したスクリプトも、以下の形式のいずれかを使用します。

-

image:///path_to_scripts_dir: S2I スクリプトが配置されているディレクトリーへのイメージ内の絶対パス。 -

file:///path_to_scripts_dir: S2I スクリプトが配置されているディレクトリーへのホスト上の相対パスまたは絶対パス。 -

http(s)://path_to_scripts_dir: S2I スクリプトが配置されているディレクトリーの URL。

| スクリプト | 説明 |

|---|---|

|

|

|

|

|

|

|

|

これらの依存関係は |

|

|

|

|

|

注記

|

S2I スクリプトの例

以下の S2I スクリプトの例は Bash で記述されています。それぞれの例では、tar の内容は /tmp/s2i ディレクトリーにデプロイメントされることが前提とされています。

assemble スクリプト:

run スクリプト:

#!/bin/bash run the application /opt/application/run.sh

#!/bin/bash

# run the application

/opt/application/run.shsave-artifacts スクリプト:

usage スクリプト:

2.5.2.6. ビルドボリュームの使用

ビルドボリュームをマウントして、実行中のビルドに、アウトプットコンテナーイメージで永続化しない情報にアクセスできます。

ビルドボリュームは、ビルド時にビルド環境や設定が必要なリポジトリーの認証情報など、機密情報のみを提供します。ビルドボリュームは、データが出力コンテナーイメージに保持される ビルド入力 とは異なります。

実行中のビルドがデータを読み取るビルドボリュームのマウントポイントは機能的に pod volume mounts に似ています。

手順

BuildConfigオブジェクトのsourceStrategy定義で、ビルドボリュームをvolumes配列に追加します。以下に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- 1 5 9

- 必須。一意な名前

- 2 6 10

- 必須。マウントポイントの絶対パス。

..または:を含めないでください。こうすることで、ビルダーが生成した宛先パスと競合しなくなります。/opt/app-root/srcは、多くの Red Hat S2I 対応イメージのデフォルトのホームディレクトリーです。 - 3 7 11

- 必須。ソースのタイプは、

ConfigMap、Secret、またはCSI。 - 4 8

- 必須。ソースの名前。

- 12

- 必須。一時 CSI ボリュームを提供するドライバー。

- 13

- オプション: true の場合、ドライバーに読み取り専用ボリュームを提供するように指示します。

- 14

- オプション: 一時 CSI ボリュームのボリューム属性。サポートされる属性キーおよび値については、CSI ドライバーのドキュメントを参照してください。

共有リソース CSI ドライバーは、テクノロジープレビュー機能としてサポートされています。

2.5.3. カスタムビルド

カスタムビルドストラテジーにより、開発者はビルドプロセス全体を対象とする特定のビルダーイメージを定義できます。独自のビルダーイメージを使用することにより、ビルドプロセスをカスタマイズできます。

カスタムビルダーイメージは、RPM またはベースイメージの構築など、ビルドプロセスのロジックに組み込まれるプレーンなコンテナーイメージです。

カスタムビルドは高いレベルの権限で実行されるため、デフォルトではユーザーが利用することはできません。クラスター管理者のパーミッションを持つ信頼できるユーザーのみにカスタムビルドを実行するためのアクセスが付与される必要があります。

2.5.3.1. カスタムビルドの FROM イメージの使用

customStrategy.from セクションを使用して、カスタムビルドに使用するイメージを指定できます。

手順

customStrategy.fromセクションを設定するには、以下を実行します。strategy: customStrategy: from: kind: "DockerImage" name: "openshift/sti-image-builder"strategy: customStrategy: from: kind: "DockerImage" name: "openshift/sti-image-builder"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.3.2. カスタムビルドでのシークレットの使用

すべてのビルドタイプに追加できるソースおよびイメージのシークレットのほかに、カスタムストラテジーを使用することにより、シークレットの任意のリストをビルダー Pod に追加できます。

2.5.3.3. カスタムビルドの環境変数の使用

環境変数をカスタムビルドプロセスで利用可能にするには、環境変数をビルド設定の customStrategy 定義に追加できます。

ここに定義された環境変数は、カスタムビルドを実行する Pod に渡されます。

手順

ビルド時に使用されるカスタムの HTTP プロキシーを定義します。

customStrategy: ... env: - name: "HTTP_PROXY" value: "http://myproxy.net:5187/"customStrategy: ... env: - name: "HTTP_PROXY" value: "http://myproxy.net:5187/"Copy to Clipboard Copied! Toggle word wrap Toggle overflow ビルド設定で定義された環境変数を管理するには、以下のコマンドを入力します。

oc set env <enter_variables>

$ oc set env <enter_variables>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.3.4. カスタムビルダーイメージの使用

OpenShift Container Platform のカスタムビルドストラテジーにより、ビルドプロセス全体を対象とする特定のビルダーイメージを定義できます。パッケージ、JAR、WAR、インストール可能な ZIP、ベースイメージなどの個別のアーティファクトを生成するためにビルドが必要な場合は、カスタムビルドストラテジーを使用してカスタムビルダーイメージを使用します。

カスタムビルダーイメージは、RPM またはベースのコンテナーイメージの構築など、ビルドプロセスのロジックに組み込まれるプレーンなコンテナーイメージです。

さらに、カスタムビルダーは、単体または統合テストを実行する CI/CD フローなどの拡張ビルドプロセスを実装できます。

2.5.3.4.1. カスタムビルダーイメージ

呼び出し時に、カスタムのビルダーイメージは、ビルドの続行に必要な情報が含まれる以下の環境変数を受け取ります。

| 変数名 | 説明 |

|---|---|

|

|

|

|

| ビルドするソースが含まれる Git リポジトリーの URL |

|

|

|

|

| ビルド時に使用する Git リポジトリーのサブディレクトリーを指定します。定義された場合にのみ表示されます。 |

|

| ビルドする Git 参照 |

|

| このビルドオブジェクトを作成した OpenShift Container Platform のマスターのバージョン |

|

| イメージをプッシュするコンテナーイメージレジストリー |

|

| ビルドするイメージのコンテナーイメージタグ名 |

|

|

|

2.5.3.4.2. カスタムビルダーのワークフロー

カスタムビルダーイメージの作成者は、ビルドプロセスを柔軟に定義できますが、ビルダーイメージは、OpenShift Container Platform 内でビルドを実行するために必要な以下の手順に従う必要があります。

-

Buildオブジェクト定義に、ビルドの入力パラメーターの必要情報をすべて含める。 - ビルドプロセスを実行する。

- ビルドでイメージが生成される場合には、ビルドの出力場所が定義されていれば、その場所にプッシュする。他の出力場所には環境変数を使用して渡すことができます。

2.5.4. パイプラインビルド

パイプラインビルドストラテジーは OpenShift Container Platform 4 では非推奨になりました。同等の機能および改善機能は、Tekton をベースとする OpenShift Container Platform Pipeline にあります。

OpenShift Container Platform の Jenkins イメージは完全にサポートされており、ユーザーは Jenkins ユーザーのドキュメントに従ってジョブで jenkinsfile を定義するか、これをソースコントロール管理システムに保存します。

開発者は、パイプラインビルドストラテジーを利用して Jenkins パイプラインプラグインで使用できるように Jenkins パイプラインを定義することができます。このビルドについては、他のビルドタイプの場合と同様に OpenShift Container Platform での起動、モニタリング、管理が可能です。

パイプラインワークフローは、ビルド設定に直接組み込むか、Git リポジトリーに配置してビルド設定で参照して jenkinsfile で定義します。

2.5.4.1. OpenShift Container Platform Pipeline について

パイプラインビルドストラテジーは OpenShift Container Platform 4 では非推奨になりました。同等の機能および改善機能は、Tekton をベースとする OpenShift Container Platform Pipeline にあります。

OpenShift Container Platform の Jenkins イメージは完全にサポートされており、ユーザーは Jenkins ユーザーのドキュメントに従ってジョブで jenkinsfile を定義するか、これをソースコントロール管理システムに保存します。

Pipeline により、OpenShift Container Platform でのアプリケーションのビルド、デプロイ、およびプロモートに対する制御が可能になります。Jenkins Pipeline ビルドストラテジー、jenkinsfiles、および OpenShift Container Platform のドメイン固有言語 (DSL) (Jenkins クライアントプラグインで提供される) の組み合わせを使用することにより、すべてのシナリオにおける高度なビルド、テスト、デプロイおよびプロモート用のパイプラインを作成できます。

OpenShift Container Platform Jenkins 同期プラグイン

OpenShift Container Platform Jenkins 同期プラグインは、ビルド設定およびビルドオブジェクトを Jenkins ジョブおよびビルドと同期し、以下を提供します。

- Jenkins での動的なジョブおよび実行の作成。

- イメージストリーム、イメージストリームタグまたは設定マップからのエージェント Pod テンプレートの動的作成。

- 環境変数の挿入。

- OpenShift Container Platform Web コンソールでのパイプラインの可視化。

- Jenkins Git プラグインとの統合。これにより、OpenShift Container Platform ビルドからの Jenkins Git プラグインにコミット情報が渡されます。

- シークレットを Jenkins 認証情報エントリーに同期。

OpenShift Container Platform Jenkins クライアントプラグイン

OpenShift Container Platform Jenkins Client プラグインは、OpenShift Container Platform API Server との高度な対話を実現するために、読み取り可能かつ簡潔で、包括的で Fluent (流れるような) スタイルの Jenkins Pipeline 構文を提供することを目的とした Jenkins プラグインです。このプラグインは、スクリプトを実行するノードで使用できる必要がある OpenShift Container Platform コマンドラインツール (oc) を使用します。

OpenShift Jenkins クライアントプラグインは Jenkins マスターにインストールされ、OpenShift Container Platform DSL がアプリケーションの jenkinsfile 内で利用可能である必要があります。このプラグインは、OpenShift Container Platform Jenkins イメージの使用時にデフォルトでインストールされ、有効にされます。

プロジェクト内で OpenShift Container Platform Pipeline を使用するには、Jenkins Pipeline ビルドストラテジーを使用する必要があります。このストラテジーはソースリポジトリーのルートで jenkinsfile を使用するようにデフォルト設定されますが、以下の設定オプションも提供します。

-

ビルド設定内のインラインの

jenkinsfileフィールド。 -

ソース

contextDirとの関連で使用するjenkinsfileの場所を参照するビルド設定内のjenkinsfilePathフィールド。

オプションの jenkinsfilePath フィールドは、ソース contextDir との関連で使用するファイルの名前を指定します。contextDir が省略される場合、デフォルトはリポジトリーのルートに設定されます。jenkinsfilePath が省略される場合、デフォルトは jenkinsfile に設定されます。

2.5.4.2. パイプラインビルド用の Jenkins ファイルの提供

パイプラインビルドストラテジーは OpenShift Container Platform 4 では非推奨になりました。同等の機能および改善機能は、Tekton をベースとする OpenShift Container Platform Pipeline にあります。

OpenShift Container Platform の Jenkins イメージは完全にサポートされており、ユーザーは Jenkins ユーザーのドキュメントに従ってジョブで jenkinsfile を定義するか、これをソースコントロール管理システムに保存します。

jenkinsfile は標準的な groovy 言語構文を使用して、アプリケーションの設定、ビルド、およびデプロイメントに対する詳細な制御を可能にします。

jenkinsfile は以下のいずれかの方法で指定できます。

- ソースコードリポジトリー内にあるファイルの使用。

-

jenkinsfileフィールドを使用してビルド設定の一部として組み込む。

最初のオプションを使用する場合、jenkinsfile を以下の場所のいずれかでアプリケーションソースコードリポジトリーに組み込む必要があります。

-

リポジトリーのルートにある

jenkinsfileという名前のファイル。 -

リポジトリーのソース

contextDirのルートにあるjenkinsfileという名前のファイル。 -

ソース

contextDirに関連して BuildConfig のJenkinsPipelineStrategyセクションのjenkinsfilePathフィールドで指定される名前のファイル (指定される場合)。 指定されない場合は、リポジトリーのルートにデフォルト設定されます。

jenkinsfile は Jenkins エージェント Pod で実行されます。 ここでは OpenShift Container Platform DSL を使用する場合に OpenShift Container Platform クライアントのバイナリーを利用可能にしておく必要があります。

手順

Jenkins ファイルを指定するには、以下のいずれかを実行できます。

- ビルド設定に Jenkins ファイルを埋め込む

- Jenkins ファイルを含む Git リポジトリーへの参照をビルド設定に追加する

埋め込み定義

Git リポジトリーへの参照

- 1

- オプションの

jenkinsfilePathフィールドは、ソースcontextDirとの関連で使用するファイルの名前を指定します。contextDirが省略される場合、デフォルトはリポジトリーのルートに設定されます。jenkinsfilePathが省略される場合、デフォルトはjenkinsfileに設定されます。

2.5.4.3. Pipeline ビルドの環境変数の使用

パイプラインビルドストラテジーは OpenShift Container Platform 4 では非推奨になりました。同等の機能および改善機能は、Tekton をベースとする OpenShift Container Platform Pipeline にあります。

OpenShift Container Platform の Jenkins イメージは完全にサポートされており、ユーザーは Jenkins ユーザーのドキュメントに従ってジョブで jenkinsfile を定義するか、これをソースコントロール管理システムに保存します。

環境変数を Pipeline ビルドプロセスで利用可能にするには、環境変数をビルド設定の jenkinsPipelineStrategy 定義に追加できます。

定義した後に、環境変数はビルド設定に関連する Jenkins ジョブのパラメーターとして設定されます。

手順

ビルド時に使用される環境変数を定義するには、YAML ファイルを編集します。

jenkinsPipelineStrategy: ... env: - name: "FOO" value: "BAR"jenkinsPipelineStrategy: ... env: - name: "FOO" value: "BAR"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

oc set env コマンドで、ビルド設定に定義した環境変数を管理することも可能です。

2.5.4.3.1. BuildConfig 環境変数と Jenkins ジョブパラメーター間のマッピング

Pipeline ストラテジーのビルド設定への変更に従い、Jenkins ジョブが作成/更新されると、ビルド設定の環境変数は Jenkins ジョブパラメーターの定義にマッピングされます。 Jenkins ジョブパラメーター定義のデフォルト値は、関連する環境変数の現在の値になります。

Jenkins ジョブの初回作成後に、パラメーターを Jenkins コンソールからジョブに追加できます。パラメーター名は、ビルド設定の環境変数名とは異なります。上記の Jenkins ジョブ用にビルドを開始すると、これらのパラメーターが使用されます。

Jenkins ジョブのビルドを開始する方法により、パラメーターの設定方法が決まります。

-

oc start-buildで開始された場合には、ビルド設定の環境変数が対応するジョブインスタンスに設定するパラメーターになります。Jenkins コンソールからパラメーターのデフォルト値に変更を加えても無視されます。ビルド設定値が優先されます。 oc start-build -eで開始する場合、-eオプションで指定される環境変数の値が優先されます。- ビルド設定にリスト表示されていない環境変数を指定する場合、それらは Jenkins ジョブパラメーター定義として追加されます。

-

Jenkins コンソールから環境変数に対応するパラメーターに加える変更は無視されます。ビルド設定および

oc start-build -eで指定する内容が優先されます。

- Jenkins コンソールで Jenkins ジョブを開始した場合には、ジョブのビルドを開始する操作の一環として、Jenkins コンソールを使用してパラメーターの設定を制御できます。

ジョブパラメーターに関連付けられる可能性のあるすべての環境変数を、ビルド設定に指定することが推奨されます。これにより、ディスク I/O が減り、Jenkins 処理時のパフォーマンスが向上します。

2.5.4.4. Pipeline ビルドのチュートリアル

パイプラインビルドストラテジーは OpenShift Container Platform 4 では非推奨になりました。同等の機能および改善機能は、Tekton をベースとする OpenShift Container Platform Pipeline にあります。

OpenShift Container Platform の Jenkins イメージは完全にサポートされており、ユーザーは Jenkins ユーザーのドキュメントに従ってジョブで jenkinsfile を定義するか、これをソースコントロール管理システムに保存します。

以下の例では、nodejs-mongodb.json テンプレートを使用して Node.js/MongoDB アプリケーションをビルドし、デプロイし、検証する OpenShift Container Platform Pipeline を作成する方法を紹介します。

手順

Jenkins マスターを作成するには、以下を実行します。

oc project <project_name>

$ oc project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc new-project <project_name>で新規プロジェクトを使用するか、作成するプロジェクトを選択します。oc new-app jenkins-ephemeral

$ oc new-app jenkins-ephemeral1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 永続ストレージを使用する場合は、

jenkins-persistentを代わりに使用します。以下の内容で

nodejs-sample-pipeline.yamlという名前のファイルを作成します。注記Jenkins Pipeline ストラテジーを使用して

Node.js/MongoDBのサンプルアプリケーションをビルドし、デプロイし、スケーリングするBuildConfigオブジェクトを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow jenkinsPipelineStrategyでBuildConfigオブジェクトを作成したら、インラインのjenkinsfileを使用して、Pipeline に指示を出します。注記この例では、アプリケーションに Git リポジトリーを設定しません。

以下の

jenkinsfileの内容は、OpenShift Container Platform DSL を使用して Groovy で記述されています。ソースリポジトリーにjenkinsfileを追加することが推奨される方法ですが、この例では YAML Literal Style を使用してBuildConfigにインラインコンテンツを追加しています。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 使用するテンプレートへのパス

- 1 2

- 作成するテンプレート名

- 3

- このビルドを実行する

node.jsのエージェント Pod をスピンアップします。 - 4

- この Pipeline に 20 分間のタイムアウトを設定します。

- 5

- このテンプレートラベルが指定されたものすべてを削除します。

- 6

- このテンプレートラベルが付いたシークレットをすべて削除します。

- 7

templatePathから新規アプリケーションを作成します。- 8

- ビルドが完了するまで最大 5 分待機します。

- 9

- デプロイメントが完了するまで最大 5 分待機します。

- 10

- すべてが正常に完了した場合は、

$ {templateName}:latestイメージに$ {templateName}-staging:latestのタグを付けます。ステージング環境向けのパイプラインのビルド設定は、変更する$ {templateName}-staging:latestイメージがないかを確認し、このイメージをステージング環境にデプロイします。

注記以前の例は、宣言型のパイプラインスタイルを使用して記述されていますが、以前のスクリプト化されたパイプラインスタイルもサポートされます。

OpenShift Container Platform クラスターに Pipeline

BuildConfigを作成します。oc create -f nodejs-sample-pipeline.yaml

$ oc create -f nodejs-sample-pipeline.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 独自のファイルを作成しない場合には、以下を実行して Origin リポジトリーからサンプルを使用できます。

oc create -f https://raw.githubusercontent.com/openshift/origin/master/examples/jenkins/pipeline/nodejs-sample-pipeline.yaml

$ oc create -f https://raw.githubusercontent.com/openshift/origin/master/examples/jenkins/pipeline/nodejs-sample-pipeline.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Pipeline を起動します。

oc start-build nodejs-sample-pipeline

$ oc start-build nodejs-sample-pipelineCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記または、OpenShift Container Platform Web コンソールで Builds → Pipeline セクションに移動して、Start Pipeline をクリックするか、Jenkins コンソールから作成した Pipeline に移動して、Build Now をクリックして Pipeline を起動できます。

パイプラインが起動したら、以下のアクションがプロジェクト内で実行されるはずです。

- ジョブインスタンスが Jenkins サーバー上で作成される

- パイプラインで必要な場合には、エージェント Pod が起動される

Pipeline がエージェント Pod で実行されるか、エージェントが必要でない場合には master で実行される

-

template=nodejs-mongodb-exampleラベルの付いた以前に作成されたリソースは削除されます。 -

新規アプリケーションおよびそれに関連するすべてのリソースは、

nodejs-mongodb-exampleテンプレートで作成されます。 ビルドは

nodejs-mongodb-exampleBuildConfigを使用して起動されます。- Pipeline は、ビルドが完了して次のステージをトリガーするまで待機します。

デプロイメントは、

nodejs-mongodb-exampleのデプロイメント設定を使用して開始されます。- パイプラインは、デプロイメントが完了して次のステージをトリガーするまで待機します。

-

ビルドとデプロイに成功すると、

nodejs-mongodb-example:latestイメージがnodejs-mongodb-example:stageとしてトリガーされます。

-

パイプラインで以前に要求されていた場合には、スレーブ Pod が削除される

注記OpenShift Container Platform Web コンソールで確認すると、最適な方法で Pipeline の実行を視覚的に把握することができます。Web コンソールにログインして、Builds → Pipelines に移動し、Pipeline を確認します。

2.5.5. Web コンソールを使用したシークレットの追加

プライベートリポジトリーにアクセスできるように、ビルド設定にシークレットを追加することができます。

手順

OpenShift Container Platform Web コンソールからプライベートリポジトリーにアクセスできるようにビルド設定にシークレットを追加するには、以下を実行します。

- 新規の OpenShift Container Platform プロジェクトを作成します。

- プライベートのソースコードリポジトリーにアクセスするための認証情報が含まれるシークレットを作成します。

- ビルド設定を作成します。

-

ビルド設定エディターページまたは Web コンソールの

create app from builder imageページで、Source Secret を設定します。 - Save をクリックします。

2.5.6. プルおよびプッシュの有効化

プライベートレジストリーへのプルを実行できるようにするには、ビルド設定にプルシークレットを設定し、プッシュします。

手順

プライベートレジストリーへのプルを有効にするには、以下を実行します。

- ビルド設定にプルシークレットを設定します。

プッシュを有効にするには、以下を実行します。

- ビルド設定にプッシュシークレットを設定します。

2.6. Buildah によるカスタムイメージビルド

OpenShift Container Platform 4.10 では、docker ソケットはホストノードにはありません。これは、カスタムビルドの mount docker socket オプションがカスタムビルドイメージ内で使用できる docker ソケットを提供しない可能性がゼロではないことを意味します。

イメージのビルドおよびプッシュにこの機能を必要とする場合、Buildah ツールをカスタムビルドイメージに追加し、これを使用してカスタムビルドロジック内でイメージをビルドし、プッシュします。以下の例は、Buildah でカスタムビルドを実行する方法を示しています。

カスタムビルドストラテジーを使用するためには、デフォルトで標準ユーザーが持たないパーミッションが必要です。このパーミッションはユーザーがクラスターで実行される特権付きコンテナー内で任意のコードを実行することを許可します。このレベルのアクセスを使用するとクラスターが危険にさらされる可能性があるため、このアクセスはクラスターで管理者権限を持つ信頼されたユーザーのみに付与される必要があります。

2.6.1. 前提条件

- カスタムビルドパーミッションを付与する 方法について確認してください。

2.6.2. カスタムビルドアーティファクトの作成

カスタムビルドイメージとして使用する必要のあるイメージを作成する必要があります。

手順

空のディレクトリーからはじめ、以下の内容を含む

Dockerfileという名前のファイルを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 同じディレクトリーに、

dockerfile.sampleという名前のファイルを作成します。このファイルはカスタムビルドイメージに組み込まれ、コンテンツビルドによって生成されるイメージを定義します。FROM registry.access.redhat.com/ubi8/ubi RUN touch /tmp/build

FROM registry.access.redhat.com/ubi8/ubi RUN touch /tmp/buildCopy to Clipboard Copied! Toggle word wrap Toggle overflow 同じディレクトリーに、

build.shという名前のファイルを作成します。このファイルには、カスタムビルドの実行時に実行されるロジックが含まれます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6.3. カスタムビルダーイメージのビルド

OpenShift Container Platform を使用してカスタムストラテジーで使用するカスタムビルダーイメージをビルドし、プッシュすることができます。

前提条件

- 新規カスタムビルダーイメージの作成に使用されるすべての入力を定義します。

手順

カスタムビルダーイメージをビルドする

BuildConfigオブジェクトを定義します。oc new-build --binary --strategy=docker --name custom-builder-image

$ oc new-build --binary --strategy=docker --name custom-builder-imageCopy to Clipboard Copied! Toggle word wrap Toggle overflow カスタムビルドイメージを作成したディレクトリーから、ビルドを実行します。

oc start-build custom-builder-image --from-dir . -F

$ oc start-build custom-builder-image --from-dir . -FCopy to Clipboard Copied! Toggle word wrap Toggle overflow ビルドの完了後に、新規のカスタムビルダーイメージが

custom-builder-image:latestという名前のイメージストリームタグのプロジェクトで利用可能になります。

2.6.4. カスタムビルダーイメージの使用

カスタムビルダーイメージとカスタムストラテジーを併用する BuildConfig オブジェクトを定義し、カスタムビルドロジックを実行することができます。

前提条件

- 新規カスタムビルダーイメージに必要なすべての入力を定義します。

- カスタムビルダーイメージをビルドします。

手順

buildconfig.yamlという名前のファイルを作成します。このファイルは、プロジェクトに作成され、実行されるBuildConfigオブジェクトを定義します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- プロジェクト名を指定します。

BuildConfigを作成します。oc create -f buildconfig.yaml

$ oc create -f buildconfig.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow imagestream.yamlという名前のファイルを作成します。このファイルはビルドがイメージをプッシュするイメージストリームを定義します。kind: ImageStream apiVersion: image.openshift.io/v1 metadata: name: sample-custom spec: {}kind: ImageStream apiVersion: image.openshift.io/v1 metadata: name: sample-custom spec: {}Copy to Clipboard Copied! Toggle word wrap Toggle overflow imagestream を作成します。

oc create -f imagestream.yaml

$ oc create -f imagestream.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow カスタムビルドを実行します。

oc start-build sample-custom-build -F

$ oc start-build sample-custom-build -FCopy to Clipboard Copied! Toggle word wrap Toggle overflow ビルドが実行されると、以前にビルドされたカスタムビルダーイメージを実行する Pod が起動します。Pod はカスタムビルダーイメージのエントリーポイントとして定義される

build.shロジックを実行します。build.shロジックは Buildah を起動し、カスタムビルダーイメージに埋め込まれたdockerfile.sampleをビルドしてから、Buildah を使用して新規イメージをsample-custom image streamにプッシュします。

2.7. 基本的なビルドの実行および設定

以下のセクションでは、ビルドの開始および中止、BuildConfigs の編集、BuildConfig の削除、ビルドの詳細の表示、およびビルドログへのアクセスを含む基本的なビルド操作についての方法を説明します。

2.7.1. ビルドの開始

現在のプロジェクトに既存のビルド設定から新規ビルドを手動で起動できます。

手順

手動でビルドを開始するには、以下のコマンドを入力します。

oc start-build <buildconfig_name>

$ oc start-build <buildconfig_name>2.7.1.1. ビルドの再実行

--from-build フラグを使用してビルドを手動で再度実行します。

手順

手動でビルドを再実行するには、以下のコマンドを入力します。

oc start-build --from-build=<build_name>

$ oc start-build --from-build=<build_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7.1.2. ビルドログのストリーミング

--follow フラグを指定して、stdout のビルドのログをストリーミングします。

手順

stdoutでビルドのログを手動でストリーミングするには、以下のコマンドを実行します。oc start-build <buildconfig_name> --follow

$ oc start-build <buildconfig_name> --followCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7.1.3. ビルド開始時の環境変数の設定

--env フラグを指定して、ビルドの任意の環境変数を設定します。

手順

必要な環境変数を指定するには、以下のコマンドを実行します。

oc start-build <buildconfig_name> --env=<key>=<value>

$ oc start-build <buildconfig_name> --env=<key>=<value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7.1.4. ソースを使用したビルドの開始

Git ソースプルまたは Dockerfile に依存してビルドするのではなく、ソースを直接プッシュしてビルドを開始することも可能です。ソースには、Git または SVN の作業ディレクトリーの内容、デプロイする事前にビルド済みのバイナリーアーティファクトのセットまたは単一ファイルのいずれかを選択できます。これは、start-build コマンドに以下のオプションのいずれかを指定して実行できます。

| オプション | 説明 |

|---|---|

|

| アーカイブし、ビルドのバイナリー入力として使用するディレクトリーを指定します。 |

|

| 単一ファイルを指定します。これはビルドソースで唯一のファイルでなければなりません。 このファイルは、元のファイルと同じファイル名で空のディレクトリーのルートに置いてください。 |

|

|

ビルドのバイナリー入力として使用するローカルリポジトリーへのパスを指定します。 |

以下のオプションをビルドに直接指定した場合には、コンテンツはビルドにストリーミングされ、現在のビルドソースの設定が上書きされます。

バイナリー入力からトリガーされたビルドは、サーバー上にソースを保存しないため、ベースイメージの変更でビルドが再度トリガーされた場合には、ビルド設定で指定されたソースが使用されます。

手順

以下のコマンドを使用してソースからビルドを開始し、タグ

v2からローカル Git リポジトリーの内容をアーカイブとして送信します。oc start-build hello-world --from-repo=../hello-world --commit=v2

$ oc start-build hello-world --from-repo=../hello-world --commit=v2Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7.2. ビルドの中止

Web コンソールまたは以下の CLI コマンドを使用して、ビルドを中止できます。

手順

手動でビルドを取り消すには、以下のコマンドを入力します。

oc cancel-build <build_name>

$ oc cancel-build <build_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7.2.1. 複数ビルドのキャンセル

以下の CLI コマンドを使用して複数ビルドを中止できます。

手順

複数ビルドを手動で取り消すには、以下のコマンドを入力します。

oc cancel-build <build1_name> <build2_name> <build3_name>

$ oc cancel-build <build1_name> <build2_name> <build3_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7.2.2. すべてのビルドのキャンセル

以下の CLI コマンドを使用し、ビルド設定からすべてのビルドを中止できます。

手順

すべてのビルドを取り消すには、以下のコマンドを実行します。

oc cancel-build bc/<buildconfig_name>

$ oc cancel-build bc/<buildconfig_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7.2.3. 指定された状態のすべてのビルドのキャンセル

特定の状態にあるビルドをすべて取り消すことができます (例: new または pending)。この際、他の状態のビルドは無視されます。

手順

特定の状態のすべてのビルドを取り消すには、以下のコマンドを入力します。

oc cancel-build bc/<buildconfig_name>

$ oc cancel-build bc/<buildconfig_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7.3. BuildConfig の編集

ビルド設定を編集するには、Developer パースペクティブの Builds ビューで Edit BuildConfig オプションを使用します。

以下のいずれかのビューを使用して BuildConfig を編集できます。

-

Form view を使用すると、標準のフォームフィールドおよびチェックボックスを使用して

BuildConfigを編集できます。 -

YAML ビュー を使用すると、操作を完全に制御して

BuildConfigを編集できます。

データを失うことなく、Form view と YAML view を切り替えることができます。Form ビュー のデータは YAML ビュー に転送されます (その逆も同様です)。

手順

-

Developer パースペクティブの Builds ビューで、メニュー

をクリックし、Edit BuildConfig オプションを表示します。

をクリックし、Edit BuildConfig オプションを表示します。

- Edit BuildConfig をクリックし、Form view オプションを表示します。

Git セクションで、アプリケーションの作成に使用するコードベースの Git リポジトリー URL を入力します。その後、URL は検証されます。

オプション: Show Advanced Git Options をクリックし、以下のような詳細を追加します。

- Git Reference: アプリケーションのビルドに使用するコードが含まれるブランチ、タグ、またはコミットを指定します。

- Context Dir: アプリケーションのビルドに使用するアプリケーションのコードが含まれるサブディレクトリーを指定します。

- Source Secret: プライベートリポジトリーからソースコードをプルするための認証情報で Secret Name を作成します。

Build from セクションで、ビルド元となるオプションを選択します。以下のオプションで使用できます。

- イメージストリームタグ は、所定のイメージストリームおよびタグのイメージを参照します。ビルド元およびプッシュ元の場所に指定するプロジェクト、イメージストリーム、およびタグを入力します。

- イメージストリームイメージ は、所定のイメージストリームのイメージとおよびイメージ名を参照します。ビルドするイメージストリームイメージを入力します。また、プッシュ先となるプロジェクト、イメージストリーム、およびタグも入力します。

- Docker image: Docker イメージは Docker イメージリポジトリーを使用して参照されます。また、プッシュ先の場所を参照するように、プロジェクト、イメージストリーム、タグを入力する必要があります。

- オプション: 環境変数 セクションでName と Value フィールドを使用して、プロジェクトに関連付けられた環境変数を追加します。環境変数を追加するには、Add Value または Add from ConfigMap と Secret を使用します。

オプション: 以下の高度なオプションを使用してアプリケーションをさらにカスタマイズできます。

- トリガー

- ビルダーイメージの変更時に新規イメージビルドをトリガーします。Add Trigger をクリックし、Type および Secret を選択して、トリガーを追加します。

- シークレット

- アプリケーションのシークレットを追加します。Add secret をクリックし、Secret および Mount point を選択して、さらにシークレットを追加します。

- Policy

- Run policy をクリックして、ビルド実行ポリシーを選択します。選択したポリシーは、ビルド設定から作成されるビルドを実行する順番を決定します。

- フック

- Run build hooks after image is built を選択して、ビルドの最後にコマンドを実行し、イメージを検証します。Hook type、Command および Arguments をコマンドに追加しあ m す。

-

Save をクリックして

BuildConfigを保存します。

2.7.4. BuildConfig の削除

以下のコマンドで BuildConfig を削除します。

手順

BuildConfigを削除するには、以下のコマンドを入力します。oc delete bc <BuildConfigName>

$ oc delete bc <BuildConfigName>Copy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、この

BuildConfigでインスタンス化されたビルドがすべて削除されます。BuildConfigを削除して、BuildConfigからインスタンス化されたビルドを保持するには、以下のコマンドの入力時に--cascade=falseフラグを指定します。oc delete --cascade=false bc <BuildConfigName>

$ oc delete --cascade=false bc <BuildConfigName>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7.5. ビルドの詳細表示

Web コンソールまたは oc describe CLI コマンドを使用して、ビルドの詳細を表示できます。

これにより、以下のような情報が表示されます。

- ビルドソース

- ビルドストラテジー

- 出力先

- 宛先レジストリーのイメージのダイジェスト

- ビルドの作成方法

ビルドが Docker または Source ストラテジーを使用する場合、oc describe 出力には、コミット ID、作成者、コミットしたユーザー、メッセージなどのビルドに使用するソースのリビジョンの情報が含まれます。

手順

ビルドの詳細を表示するには、以下のコマンドを入力します。

oc describe build <build_name>

$ oc describe build <build_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7.6. ビルドログへのアクセス

Web コンソールまたは CLI を使用してビルドログにアクセスできます。

手順

ビルドを直接使用してログをストリーミングするには、以下のコマンドを入力します。

oc describe build <build_name>

$ oc describe build <build_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7.6.1. BuildConfig ログへのアクセス

Web コンソールまたは CLI を使用して BuildConfig ログにアクセスできます。

手順

BuildConfigの最新ビルドのログをストリーミングするには、以下のコマンドを入力します。oc logs -f bc/<buildconfig_name>

$ oc logs -f bc/<buildconfig_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7.6.2. 特定バージョンのビルドについての BuildConfig ログへのアクセス

Web コンソールまたは CLI を使用して、BuildConfig についての特定バージョンのビルドのログにアクセスすることができます。

手順

BuildConfigの特定バージョンのビルドのログをストリームするには、以下のコマンドを入力します。oc logs --version=<number> bc/<buildconfig_name>

$ oc logs --version=<number> bc/<buildconfig_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7.6.3. ログの冗長性の有効化

詳細の出力を有効にするには、BuildConfig 内の sourceStrategy または dockerStrategy の一部として BUILD_LOGLEVEL 環境変数を指定します。

管理者は、env/BUILD_LOGLEVEL を設定して、OpenShift Container Platform インスタンス全体のデフォルトのビルドの詳細レベルを設定できます。このデフォルトは、指定の BuildConfig で BUILD_LOGLEVEL を指定することで上書きできます。コマンドラインで --build-loglevel を oc start-build に渡すことで、バイナリー以外のビルドについて優先順位の高い上書きを指定することができます。

ソースビルドで利用できるログレベルは以下のとおりです。

| レベル 0 |

|

| レベル 1 | 実行したプロセスに関する基本情報を生成します。 |

| レベル 2 | 実行したプロセスに関する詳細情報を生成します。 |

| レベル 3 | 実行したプロセスに関する詳細情報と、アーカイブコンテンツのリストを生成します。 |

| レベル 4 | 現時点ではレベル 3 と同じ情報を生成します。 |

| レベル 5 | これまでのレベルで記載したすべての内容と docker のプッシュメッセージを提供します。 |

手順

詳細の出力を有効にするには、

BuildConfig内のsourceStrategyまたはdockerStrategyの一部としてBUILD_LOGLEVEL環境変数を渡します。sourceStrategy: ... env: - name: "BUILD_LOGLEVEL" value: "2"sourceStrategy: ... env: - name: "BUILD_LOGLEVEL" value: "2"1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- この値を任意のログレベルに調整します。

2.8. ビルドのトリガーおよび変更

以下のセクションでは、ビルドフックを使用してビルドをトリガーし、ビルドを変更する方法についての概要を説明します。

2.8.1. ビルドトリガー

BuildConfig の定義時に、BuildConfig を実行する必要のある状況を制御するトリガーを定義できます。以下のビルドトリガーを利用できます。

- Webhook

- イメージの変更

- 設定の変更

2.8.1.1. Webhook のトリガー

Webhook のトリガーにより、要求を OpenShift Container Platform API エンドポイントに送信して新規ビルドをトリガーできます。GitHub、GitLab、Bitbucket または Generic webhook を使用してこれらのトリガーを定義できます。

OpenShift Container Platform の Webhook は現在、Git ベースのソースコード管理システム (SCM) システムのそれぞれのプッシュイベントの類似のバージョンのみをサポートしています。その他のイベントタイプはすべて無視されます。

プッシュイベントを処理する場合に、OpenShift Container Platform コントロールプレーンホストは、イベント内のブランチ参照が、対応の BuildConfig のブランチ参照と一致しているかどうを確認します。一致する場合には、OpenShift Container Platform ビルドの Webhook イベントに記載されているのと全く同じコミット参照がチェックアウトされます。一致しない場合には、ビルドはトリガーされません。

oc new-app および oc new-build は GitHub および Generic Webhook トリガーを自動的に作成しますが、それ以外の Webhook トリガーが必要な場合には手動で追加する必要があります。トリガーを設定して、トリガーを手動で追加できます。

Webhook すべてに対して、WebHookSecretKey という名前のキーでシークレットと、Webook の呼び出し時に提供される値を定義する必要があります。webhook の定義で、このシークレットを参照する必要があります。このシークレットを使用することで URL が一意となり、他の URL でビルドがトリガーされないようにします。キーの値は、webhook の呼び出し時に渡されるシークレットと比較されます。

たとえば、mysecret という名前のシークレットを参照する GitHub webhook は以下のとおりです。

type: "GitHub"

github:

secretReference:

name: "mysecret"

type: "GitHub"

github:

secretReference:

name: "mysecret"

次に、シークレットは以下のように定義します。シークレットの値は base64 エンコードされており、この値は Secret オブジェクトの data フィールドに必要である点に注意してください。

2.8.1.1.1. GitHub Webhook の使用

GitHub webhook は、リポジトリーの更新時に GitHub からの呼び出しを処理します。トリガーを定義する際に、シークレットを指定する必要があります。このシークレットは、Webhook の設定時に GitHub に指定する URL に追加されます。

GitHub Webhook の定義例:

type: "GitHub"

github:

secretReference:

name: "mysecret"

type: "GitHub"

github:

secretReference:

name: "mysecret"

Webhook トリガーの設定で使用されるシークレットは、GitHub UI で Webhook の設定時に表示される secret フィールドとは異なります。Webhook トリガー設定で使用するシークレットは、Webhook URL を一意にして推測ができないようにし、GitHub UI のシークレットは、任意の文字列フィールドで、このフィールドを使用して本体の HMAC hex ダイジェストを作成して、X-Hub-Signature ヘッダーとして送信します。

oc describe コマンドは、ペイロード URL を GitHub Webhook URL として返します (Webhook URL の表示を参照)。 ペイロード URL は以下のように設定されます。

出力例

https://<openshift_api_host:port>/apis/build.openshift.io/v1/namespaces/<namespace>/buildconfigs/<name>/webhooks/<secret>/github

https://<openshift_api_host:port>/apis/build.openshift.io/v1/namespaces/<namespace>/buildconfigs/<name>/webhooks/<secret>/github前提条件

-

GitHub リポジトリーから

BuildConfigを作成します。

手順

GitHub Webhook を設定するには以下を実行します。

GitHub リポジトリーから

BuildConfigを作成した後に、以下を実行します。oc describe bc/<name-of-your-BuildConfig>

$ oc describe bc/<name-of-your-BuildConfig>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のように、上記のコマンドは Webhook GitHub URL を生成します。

出力例

<https://api.starter-us-east-1.openshift.com:443/apis/build.openshift.io/v1/namespaces/<namespace>/buildconfigs/<name>/webhooks/<secret>/github

<https://api.starter-us-east-1.openshift.com:443/apis/build.openshift.io/v1/namespaces/<namespace>/buildconfigs/<name>/webhooks/<secret>/githubCopy to Clipboard Copied! Toggle word wrap Toggle overflow - GitHub の Web コンソールから、この URL を GitHub にカットアンドペーストします。

- GitHub リポジトリーで、Settings → Webhooks から Add Webhook を選択します。

- Payload URL フィールドに、URL の出力を貼り付けます。

-

Content Type を GitHub のデフォルト

application/x-www-form-urlencodedからapplication/jsonに変更します。 Add webhook をクリックします。

webhook の設定が正常に完了したことを示す GitHub のメッセージが表示されます。

これで変更を GitHub リポジトリーにプッシュする際に新しいビルドが自動的に起動し、ビルドに成功すると新しいデプロイメントが起動します。

注記Gogs は、GitHub と同じ webhook のペイロード形式をサポートします。そのため、Gogs サーバーを使用する場合は、GitHub webhook トリガーを

BuildConfigに定義すると、Gogs サーバー経由でもトリガーされます。

payload.jsonなどの有効な JSON ペイロードがファイルに含まれる場合には、curlを使用して webhook を手動でトリガーできます。curl -H "X-GitHub-Event: push" -H "Content-Type: application/json" -k -X POST --data-binary @payload.json https://<openshift_api_host:port>/apis/build.openshift.io/v1/namespaces/<namespace>/buildconfigs/<name>/webhooks/<secret>/github

$ curl -H "X-GitHub-Event: push" -H "Content-Type: application/json" -k -X POST --data-binary @payload.json https://<openshift_api_host:port>/apis/build.openshift.io/v1/namespaces/<namespace>/buildconfigs/<name>/webhooks/<secret>/githubCopy to Clipboard Copied! Toggle word wrap Toggle overflow -kの引数は、API サーバーに正しく署名された証明書がない場合にのみ必要です。

ビルドは、GitHub Webhook イベントからの ref 値が、BuildConfig リソースの source.git フィールドで指定された ref 値と一致する場合にのみトリガーされます。

2.8.1.1.2. GitLab Webhook の使用

GitLab Webhook は、リポジトリーの更新時の GitLab による呼び出しを処理します。GitHub トリガーでは、シークレットを指定する必要があります。以下の例は、BuildConfig 内のトリガー定義の YAML です。

type: "GitLab"

gitlab:

secretReference:

name: "mysecret"

type: "GitLab"

gitlab:

secretReference:

name: "mysecret"

oc describe コマンドは、ペイロード URL を GitLab Webhook URL として返します。 ペイロード URL は以下のように設定されます。

出力例

https://<openshift_api_host:port>/apis/build.openshift.io/v1/namespaces/<namespace>/buildconfigs/<name>/webhooks/<secret>/gitlab