This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.モニタリング

OpenShift Container Platform でのモニタリングスタックの設定および使用

概要

第1章 モニタリングの概要

1.1. OpenShift Container Platform モニタリングについて

OpenShift Container Platform には、コアプラットフォームコンポーネントのモニタリングを提供する事前に設定され、事前にインストールされた自己更新型のモニタリングスタックが含まれます。また、ユーザー定義プロジェクトのモニタリングを有効 にするオプションもあります。

クラスター管理者は、サポートされている設定で モニタリングスタックを設定 できます。OpenShift Container Platform は、追加設定が不要のモニタリングのベストプラクティスを提供します。

管理者にクラスターの問題について即時に通知するアラートのセットがデフォルトで含まれます。OpenShift Container Platform Web コンソールのデフォルトのダッシュボードには、クラスターの状態をすぐに理解できるようにするクラスターのメトリックの視覚的な表示が含まれます。OpenShift Container Platform Web コンソールを使用して、メトリクスの表示と管理、アラート、および モニタリングダッシュボードの確認 することができます。

OpenShift Container Platform Web コンソールの Observe セクションでは、metrics、alerts、monitoring dashboards、metrics targets などのモニタリング機能にアクセスして管理できます。

OpenShift Container Platform のインストール後に、クラスター管理者はオプションでユーザー定義プロジェクトのモニタリングを有効にできます。この機能を使用することで、クラスター管理者、開発者、および他のユーザーは、サービスと Pod を独自のプロジェクトでモニターする方法を指定できます。クラスター管理者は、Troubleshooting monitoring issues で、Prometheus によるユーザーメトリックの使用不可やディスクスペースの大量消費などの一般的な問題に対する回答を見つけることができます。

1.2. モニタリングスタックについて

OpenShift Container Platform モニタリングスタックは、Prometheus オープンソースプロジェクトおよびその幅広いエコシステムをベースとしています。モニタリングスタックには、以下のコンポーネントが含まれます。

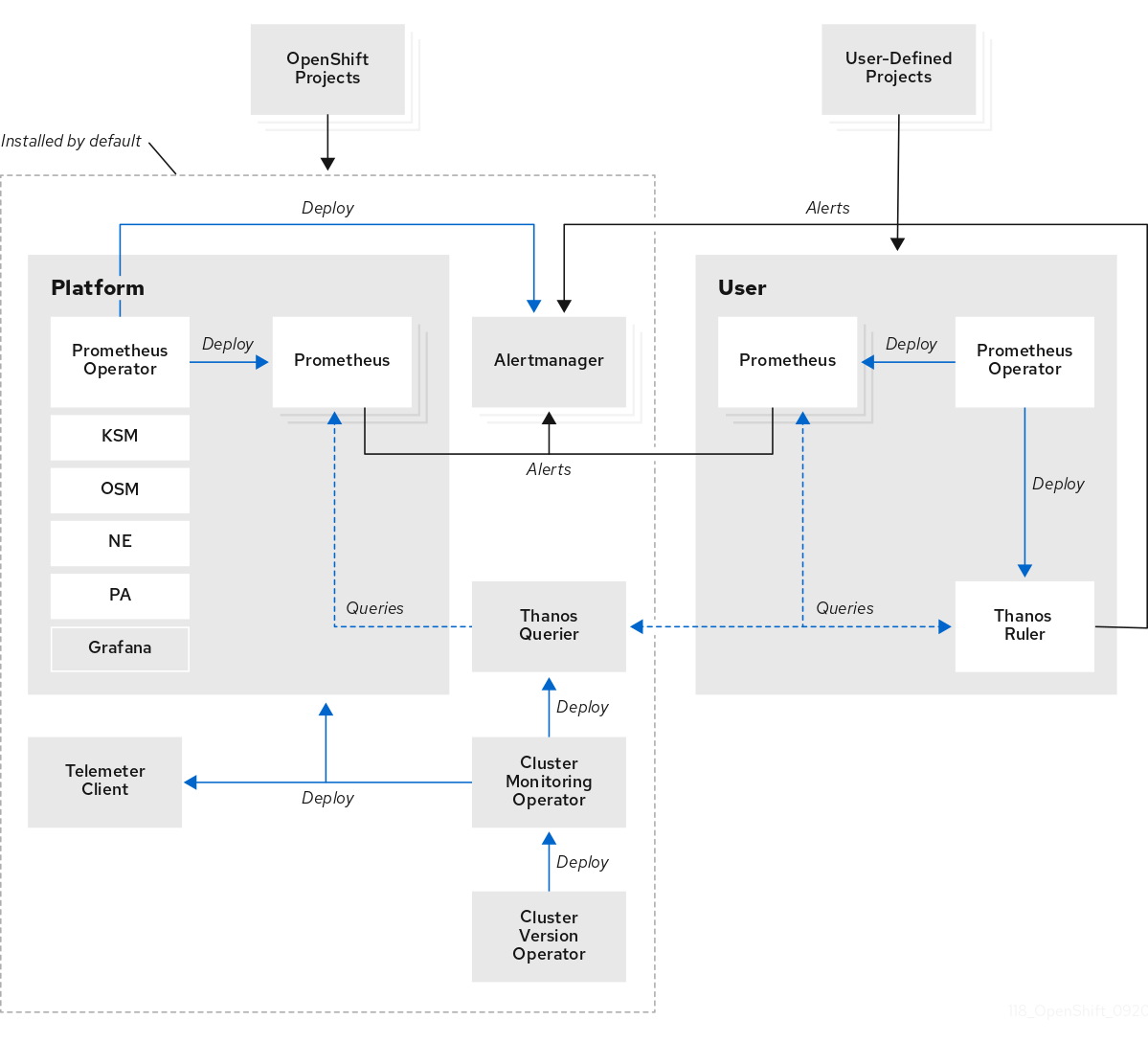

-

デフォルトのプラットフォームモニタリングコンポーネント。プラットフォームモニタリングコンポーネントのセットは、OpenShift Container Platform のインストール時にデフォルトで

openshift-monitoringプロジェクトにインストールされます。これにより、Kubernetes サービスを含む OpenShift Container Platform のコアコンポーネントのモニタリング機能が提供されます。デフォルトのモニタリングスタックは、クラスターのリモートのヘルスモニタリングも有効にします。これらのコンポーネントは、以下の図の Installed by default (デフォルトのインストール) セクションで説明されています。 -

ユーザー定義のプロジェクトをモニターするためのコンポーネント。オプションでユーザー定義プロジェクトのモニタリングを有効にした後に、追加のモニタリングコンポーネントは

openshift-user-workload-monitoringプロジェクトにインストールされます。これにより、ユーザー定義プロジェクトのモニタリング機能が提供されます。これらのコンポーネントは、以下の図の User (ユーザー) セクションで説明されています。

1.2.1. デフォルトのモニタリングコンポーネント

デフォルトで、OpenShift Container Platform 4.10 モニタリングスタックには、以下のコンポーネントが含まれます。

| コンポーネント | 説明 |

|---|---|

| クラスターモニタリング Operator | Cluster Monitoring Operator (CMO) は、モニタリングスタックの中心的なコンポーネントです。Prometheus および Alertmanager インスタンス、Thanos Querier、Telemeter Client、およびメトリクスターゲットをデプロイ、管理、および自動更新します。CMO は Cluster Version Operator (CVO) によってデプロイされます。 |

| Prometheus Operator |

|

| Prometheus | Prometheus は、OpenShift Container Platform モニタリングスタックのベースとなるモニタリングシステムです。Prometheus は Time Series を使用するデータベースであり、メトリクスのルール評価エンジンです。Prometheus は処理のためにアラートを Alertmanager に送信します。 |

| Prometheus アダプター |

Prometheus アダプター (上記の図の PA) は、Prometheus で使用する Kubernetes ノードおよび Pod クエリーを変換します。変換されるリソースメトリクスには、CPU およびメモリーの使用率メトリクスが含まれます。Prometheus アダプターは、Horizontal Pod Autoscaling のクラスターリソースメトリクス API を公開します。Prometheus アダプターは |

| Alertmanager | Alertmanager サービスは、Prometheus から送信されるアラートを処理します。また、Alertmanager は外部の通知システムにアラートを送信します。 |

|

|

|

|

|

OpenShift Container Platform 固有のリソースのメトリクスを追加すると、 |

|

|

|

| Thanos Querier | Thanos Querier は、単一のマルチテナントインターフェイスで、OpenShift Container Platform のコアメトリクスおよびユーザー定義プロジェクトのメトリクスを集約し、オプションでこれらの重複を排除します。 |

| Grafana | Grafana 解析プラットフォームは、メトリクスの分析および可視化のためのダッシュボードを提供します。モニタリングスタックおよびダッシュボードと共に提供される Grafana インスタンスは読み取り専用です。 |

| Telemeter クライアント | Telemeter Client は、クラスターのリモートヘルスモニタリングを容易にするために、プラットフォーム Prometheus インスタンスから Red Hat にデータのサブセクションを送信します。 |

モニターリグスタックのすべてのコンポーネントはスタックによってモニターされ、OpenShift Container Platform の更新時に自動的に更新されます。

モニタリングスタックのすべてのコンポーネントは、クラスター管理者が一元的に設定する TLS セキュリティープロファイル設定を使用します。TLS セキュリティー設定を使用するモニタリングスタックコンポーネントを設定する場合、コンポーネントはグローバル OpenShift Container Platform apiservers.config.openshift.io/cluster リソースの tlsSecurityProfile フィールドにすでに存在する TLS セキュリティープロファイル設定を使用します。

1.2.2. デフォルトのモニタリングターゲット

スタック自体のコンポーネントに加え、デフォルトのモニタリングスタックは以下をモニターします。

- CoreDNS

- Elasticsearch(ロギングがインストールされている場合)

- etcd

- Fluentd(ロギングがインストールされている場合)

- HAProxy

- イメージレジストリー

- Kubelets

- Kubernetes API サーバー

- Kubernetes コントローラーマネージャー

- Kubernetes スケジューラー

- OpenShift API サーバー

- OpenShift Controller Manager

- Operator Lifecycle Manager (OLM)

各 OpenShift Container Platform コンポーネントはそれぞれのモニタリング設定を行います。OpenShift Container Platform コンポーネントのモニタリングに関する問題については、Jira 問題 で一般的なモニタリングコンポーネントについてではなく、特定のコンポーネントに対してバグを報告してください。

他の OpenShift Container Platform フレームワークのコンポーネントもメトリクスを公開する場合があります。詳細については、それぞれのドキュメントを参照してください。

1.2.3. ユーザー定義プロジェクトをモニターするためのコンポーネント

OpenShift Container Platform 4.10 には、ユーザー定義プロジェクトでサービスおよび Pod をモニターできるモニタリングスタックのオプションの拡張機能が含まれています。この機能には、以下のコンポーネントが含まれます。

| コンポーネント | 説明 |

|---|---|

| Prometheus Operator |

|

| Prometheus | Prometheus は、ユーザー定義のプロジェクト用にモニタリング機能が提供されるモニタリングシステムです。Prometheus は処理のためにアラートを Alertmanager に送信します。 |

| Thanos Ruler | Thanos Ruler は、別のプロセスとしてデプロイされる Prometheus のルール評価エンジンです。OpenShift Container Platform 4.10 では、Thanos Ruler はユーザー定義プロジェクトをモニタリングするためのルールおよびアラート評価を提供します。 |

上記の表のコンポーネントは、モニタリングがユーザー定義のプロジェクトに対して有効にされた後にデプロイされます。

モニターリグスタックのすべてのコンポーネントはスタックによってモニターされ、OpenShift Container Platform の更新時に自動的に更新されます。

1.2.4. ユーザー定義プロジェクトのターゲットのモニタリング

モニタリングがユーザー定義プロジェクトについて有効にされている場合には、以下をモニターできます。

- ユーザー定義プロジェクトのサービスエンドポイント経由で提供されるメトリクス。

- ユーザー定義プロジェクトで実行される Pod。

1.3. OpenShift Container Platform モニタリングの一般用語集

この用語集では、OpenShift Container Platform アーキテクチャーで使用される一般的な用語を定義します。

- Alertmanager

- Alertmanager は、Prometheus から受信したアラートを処理します。また、Alertmanager は外部の通知システムにアラートを送信します。

- アラートルール

- アラートルールには、クラスター内の特定の状態を示す一連の条件が含まれます。アラートは、これらの条件が true の場合にトリガーされます。アラートルールには、アラートのルーティング方法を定義する重大度を割り当てることができます。

- クラスターモニタリング Operator

- Cluster Monitoring Operator (CMO) は、モニタリングスタックの中心的なコンポーネントです。Thanos Querier、Telemeter Client、メトリクスターゲットなどの Prometheus インスタンスをデプロイおよび管理して、それらが最新であることを確認します。CMO は Cluster Version Operator (CVO) によってデプロイされます。

- Cluster Version Operator

- Cluster Version Operator (CVO) はクラスター Operator のライフサイクルを管理し、その多くはデフォルトで OpenShift Container Platform にインストールされます。

- 設定マップ

-

ConfigMap は、設定データを Pod に注入する方法を提供します。タイプ

ConfigMapのボリューム内の ConfigMap に格納されたデータを参照できます。Pod で実行しているアプリケーションは、このデータを使用できます。 - Container

- コンテナーは、ソフトウェアとそのすべての依存関係を含む軽量で実行可能なイメージです。コンテナーは、オペレーティングシステムを仮想化します。そのため、コンテナーはデータセンターからパブリッククラウド、プライベートクラウド、開発者のラップトップなどまで、場所を問わずコンテナーを実行できます。

- カスタムリソース (CR)

- CR は Kubernetes API のエクステンションです。カスタムリソースを作成できます。

- etcd

- etcd は OpenShift Container Platform のキーと値のストアであり、すべてのリソースオブジェクトの状態を保存します。

- Fluentd

- Fluentd は、ノードからログを収集し、そのログを Elasticsearch に送ります。

- Kubelets

- ノード上で実行され、コンテナーマニフェストを読み取ります。定義されたコンテナーが開始され、実行されていることを確認します。

- Kubernetes API サーバー

- Kubernetes API サーバーは、API オブジェクトのデータを検証して設定します。

- Kubernetes コントローラーマネージャー

- Kubernetes コントローラーマネージャーは、クラスターの状態を管理します。

- Kubernetes スケジューラー

- Kubernetes スケジューラーは Pod をノードに割り当てます。

- labels

- ラベルは、Pod などのオブジェクトのサブセットを整理および選択するために使用できるキーと値のペアです。

- node

- OpenShift Container Platform クラスター内のワーカーマシン。ノードは、仮想マシン (VM) または物理マシンのいずれかです。

- Operator

- OpenShift Container Platform クラスターで Kubernetes アプリケーションをパッケージ化、デプロイ、および管理するための推奨される方法。Operator は、人間による操作に関する知識を取り入れて、簡単にパッケージ化してお客様と共有できるソフトウェアにエンコードします。

- Operator Lifecycle Manager (OLM)

- OLM は、Kubernetes ネイティブアプリケーションのライフサイクルをインストール、更新、および管理するのに役立ちます。OLM は、Operator を効果的かつ自動化されたスケーラブルな方法で管理するために設計されたオープンソースのツールキットです。

- 永続ストレージ

- デバイスがシャットダウンされた後でもデータを保存します。Kubernetes は永続ボリュームを使用して、アプリケーションデータを保存します。

- 永続ボリューム要求 (PVC)

- PVC を使用して、PersistentVolume を Pod にマウントできます。クラウド環境の詳細を知らなくてもストレージにアクセスできます。

- pod

- Pod は、Kubernetes における最小の論理単位です。Pod には、ワーカーノードで実行される 1 つ以上のコンテナーが含まれます。

- Prometheus

- Prometheus は、OpenShift Container Platform モニタリングスタックのベースとなるモニタリングシステムです。Prometheus は Time Series を使用するデータベースであり、メトリクスのルール評価エンジンです。Prometheus は処理のためにアラートを Alertmanager に送信します。

- Prometheus アダプター

- Prometheus アダプターは、Prometheus で使用するために Kubernetes ノードと Pod のクエリーを変換します。変換されるリソースメトリクスには、CPU およびメモリーの使用率が含まれます。Prometheus アダプターは、Horizontal Pod Autoscaling のクラスターリソースメトリクス API を公開します。

- Prometheus Operator

-

openshift-monitoringプロジェクトの Prometheus Operator(PO) は、プラットフォーム Prometheus インスタンスおよび Alertmanager インスタンスを作成し、設定し、管理します。また、Kubernetes ラベルのクエリーに基づいてモニタリングターゲットの設定を自動生成します。 - サイレンス

- サイレンスをアラートに適用し、アラートの条件が true の場合に通知が送信されることを防ぐことができます。初期通知後はアラートをミュートにして、根本的な問題の解決に取り組むことができます。

- storage

- OpenShift Container Platform は、オンプレミスおよびクラウドプロバイダーの両方で、多くのタイプのストレージをサポートします。OpenShift Container Platform クラスターで、永続データおよび非永続データ用のコンテナーストレージを管理できます。

- Thanos Ruler

- Thanos Ruler は、別のプロセスとしてデプロイされる Prometheus のルール評価エンジンです。OpenShift Container Platform では、Thanos Ruler はユーザー定義プロジェクトをモニタリングするためのルールおよびアラート評価を提供します。

- Web コンソール

- OpenShift Container Platform を管理するためのユーザーインターフェイス (UI)。

1.5. 次のステップ

第2章 モニタリングスタックの設定

OpenShift Container Platform 4 インストールプログラムは、インストール前の少数の設定オプションのみを提供します。ほとんどの OpenShift Container Platform フレームワークコンポーネント (クラスターモニタリングスタックを含む) の設定はインストール後に行われます。

このセクションでは、サポートされている設定内容を説明し、モニタリングスタックの設定方法を示し、いくつかの一般的な設定シナリオを示します。

2.1. 前提条件

- モニタリングスタックには、追加のリソース要件があります。コンピューティングリソースの推奨事項については、Cluster Monitoring Operator のスケーリング を参照し、十分なリソースがあることを確認してください。

2.2. モニタリングのメンテナンスおよびサポート

OpenShift Container Platform モニタリングの設定は、本書で説明されているオプションを使用して行う方法がサポートされている方法です。サポートされていない他の設定は使用しないでください。設定のパラダイムが Prometheus リリース間で変更される可能性があり、このような変更には、設定のすべての可能性が制御されている場合のみ適切に対応できます。本セクションで説明されている設定以外の設定を使用する場合、cluster-monitoring-operator が差分を調整するため、変更内容は失われます。Operator はデフォルトで定義された状態へすべてをリセットします。

2.2.1. モニタリングのサポートに関する考慮事項

以下の変更は明示的にサポートされていません。

-

追加の

ServiceMonitor、PodMonitor、およびPrometheusRuleオブジェクトをopenshift-*およびkube-*プロジェクトに作成します。 openshift-monitoringまたはopenshift-user-workload-monitoringプロジェクトにデプロイされるリソースまたはオブジェクト変更OpenShift Container Platform モニタリングスタックによって作成されるリソースは、後方互換性の保証がないために他のリソースで使用されることは意図されていません。注記Alertmanager 設定は、

openshift-monitoringプロジェクトにシークレットリソースとしてデプロイされます。Alertmanager の追加ルートを設定するには、そのシークレットをデコードし、変更し、その後にエンコードする必要があります。この手順は、前述のステートメントに対してサポートされる例外です。- スタックのリソースの変更。OpenShift Container Platform モニタリングスタックは、そのリソースが常に期待される状態にあることを確認します。これらが変更される場合、スタックはこれらをリセットします。

-

ユーザー定義ワークロードの

openshift-*、およびkube-*プロジェクトへのデプロイ。これらのプロジェクトは Red Hat が提供するコンポーネント用に予約され、ユーザー定義のワークロードに使用することはできません。 - モニタリングスタック Grafana インスタンスの変更。

- カスタム Prometheus インスタンスの OpenShift Container Platform へのインストール。カスタムインスタンスは、Prometheus Operator によって管理される Prometheus カスタムリソース (CR) です。

-

Prometheus Operator での

Probeカスタムリソース定義 (CRD) による現象ベースのモニタリングの有効化。 -

Prometheus Operator での

AlertmanagerConfigCRD を使用した Alertmanager 設定の変更。

メトリクス、記録ルールまたはアラートルールの後方互換性を保証されません。

2.2.2. Operator のモニタリングについてのサポートポリシー

モニタリング Operator により、OpenShift Container Platform モニタリングリソースの設定およびテスト通りに機能することを確認できます。Operator の Cluster Version Operator (CVO) コントロールがオーバーライドされる場合、Operator は設定の変更に対応せず、クラスターオブジェクトの意図される状態を調整したり、更新を受信したりしません。

Operator の CVO コントロールのオーバーライドはデバッグ時に役立ちますが、これはサポートされず、クラスター管理者は個々のコンポーネントの設定およびアップグレードを完全に制御することを前提としています。

Cluster Version Operator のオーバーライド

spec.overrides パラメーターを CVO の設定に追加すると、管理者はコンポーネントについての CVO の動作にオーバーライドの一覧を追加できます。コンポーネントについて spec.overrides[].unmanaged パラメーターを true に設定すると、クラスターのアップグレードがブロックされ、CVO のオーバーライドが設定された後に管理者にアラートが送信されます。

Disabling ownership via cluster version overrides prevents upgrades. Please remove overrides before continuing.

Disabling ownership via cluster version overrides prevents upgrades. Please remove overrides before continuing.CVO のオーバーライドを設定すると、クラスター全体がサポートされていない状態になり、モニタリングスタックをその意図された状態に調整されなくなります。これは Operator に組み込まれた信頼性の機能に影響を与え、更新が受信されなくなります。サポートを継続するには、オーバーライドを削除した後に、報告された問題を再現する必要があります。

2.3. モニタリングスタックの設定の準備

モニタリング設定マップを作成し、更新してモニタリングスタックを設定できます。

2.3.1. クラスターモニタリング設定マップの作成

OpenShift Container Platform のコアモニタリングコンポーネントを設定するには、cluster-monitoring-config ConfigMap オブジェクトを openshift-monitoring プロジェクトに作成する必要があります。

変更を cluster-monitoring-config ConfigMap オブジェクトに保存すると、openshift-monitoring プロジェクトの Pod の一部またはすべてが再デプロイされる可能性があります。これらのコンポーネントが再デプロイするまで時間がかかる場合があります。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

OpenShift CLI (

oc) がインストールされている。

手順

cluster-monitoring-configConfigMapオブジェクトが存在するかどうかを確認します。oc -n openshift-monitoring get configmap cluster-monitoring-config

$ oc -n openshift-monitoring get configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow ConfigMapオブジェクトが存在しない場合:以下の YAML マニフェストを作成します。以下の例では、このファイルは

cluster-monitoring-config.yamlという名前です。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 設定を適用して

ConfigMapを作成します。oc apply -f cluster-monitoring-config.yaml

$ oc apply -f cluster-monitoring-config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.2. ユーザー定義のワークロードモニタリング設定マップの作成

ユーザー定義プロジェクトをモニターするコンポーネントを設定するには、user-workload-monitoring-config ConfigMap オブジェクトを openshift-user-workload-monitoring プロジェクトに作成する必要があります。

変更を user-workload-monitoring-config ConfigMap オブジェクトに保存すると、openshift-user-workload-monitoring プロジェクトの Pod の一部またはすべてが再デプロイされる可能性があります。これらのコンポーネントが再デプロイするまで時間がかかる場合があります。ユーザー定義プロジェクトのモニタリングを最初に有効にする前に設定マップを作成し、設定することができます。これにより、Pod を頻繁に再デプロイする必要がなくなります。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

OpenShift CLI (

oc) がインストールされている。

手順

user-workload-monitoring-configConfigMapオブジェクトが存在するかどうかを確認します。oc -n openshift-user-workload-monitoring get configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring get configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow user-workload-monitoring-configConfigMapオブジェクトが存在しない場合:以下の YAML マニフェストを作成します。以下の例では、このファイルは

user-workload-monitoring-config.yamlという名前です。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 設定を適用して

ConfigMapを作成します。oc apply -f user-workload-monitoring-config.yaml

$ oc apply -f user-workload-monitoring-config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記user-workload-monitoring-configConfigMapオブジェクトに適用される設定は、クラスター管理者がユーザー定義プロジェクトのモニタリングを有効にしない限りアクティブにされません。

2.4. モニタリングスタックの設定

OpenShift Container Platform 4.10 では、cluster-monitoring-config または user-workload-monitoring-config ConfigMap オブジェクトを使用して、モニタリングスタックを設定できます。設定マップはクラスターモニタリング Operator (CMO) を設定し、その後にスタックのコンポーネントが設定されます。

前提条件

OpenShift Container Platform のコアモニタリングコンポーネントを設定する場合、以下を実行します。

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。

-

ユーザー定義のプロジェクトをモニターするコンポーネントを設定する場合:

-

cluster-adminクラスターロールを持つユーザーとして、またはopenshift-user-workload-monitoringプロジェクトのuser-workload-monitoring-config-editロールを持つユーザーとして、クラスターにアクセスできる。 -

user-workload-monitoring-configConfigMapオブジェクトを作成している。

-

-

OpenShift CLI (

oc) がインストールされている。

手順

ConfigMapオブジェクトを編集します。OpenShift Container Platform のコアモニタリングコンポーネントを設定するには、以下を実行します。

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 設定を、

data/config.yamlの下に値とキーのペア<component_name>: <component_configuration>として追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow <component>および<configuration_for_the_component>を随時置き換えます。以下の

ConfigMapオブジェクトの例は、Prometheus の永続ボリューム要求 (PVC) を設定します。これは、OpenShift Container Platform のコアコンポーネントのみをモニターする Prometheus インスタンスに関連します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Prometheus コンポーネントを定義し、後続の行はその設定を定義します。

ユーザー定義のプロジェクトをモニターするコンポーネントを設定するには、以下を実行します。

openshift-user-workload-monitoringプロジェクトでuser-workload-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 設定を、

data/config.yamlの下に値とキーのペア<component_name>: <component_configuration>として追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow <component>および<configuration_for_the_component>を随時置き換えます。以下の

ConfigMapオブジェクトの例は、Prometheus のデータ保持期間および最小コンテナーリソース要求を設定します。これは、ユーザー定義のプロジェクトのみをモニターする Prometheus インスタンスに関連します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記Prometheus 設定マップコンポーネントは、

cluster-monitoring-configConfigMapオブジェクトでprometheusK8sと呼ばれ、user-workload-monitoring-configConfigMapオブジェクトでprometheusと呼ばれます。

ファイルを保存して、変更を

ConfigMapオブジェクトに適用します。新規設定の影響を受けた Pod は自動的に再起動されます。注記user-workload-monitoring-configConfigMapオブジェクトに適用される設定は、クラスター管理者がユーザー定義プロジェクトのモニタリングを有効にしない限りアクティブにされません。警告変更がモニタリング設定マップに保存されると、関連するプロジェクトの Pod およびその他のリソースが再デプロイされる可能性があります。該当するプロジェクトの実行中のモニタリングプロセスも再起動する可能性があります。

2.5. 設定可能なモニタリングコンポーネント

以下の表は、設定可能なモニタリングコンポーネントと、cluster-monitoring-config および user-workload-monitoring-config ConfigMap オブジェクトでコンポーネントを指定するために使用されるキーを示しています。

| コンポーネント | cluster-monitoring-config 設定マップキー | user-workload-monitoring-config 設定マップキー |

|---|---|---|

| Prometheus Operator |

|

|

| Prometheus |

|

|

| Alertmanager |

| |

| kube-state-metrics |

| |

| openshift-state-metrics |

| |

| Grafana |

| |

| Telemeter クライアント |

| |

| Prometheus アダプター |

| |

| Thanos Querier |

| |

| Thanos Ruler |

|

Prometheus キーは、cluster-monitoring-config ConfigMap で prometheusK8s と呼ばれ、user-workload-monitoring-config ConfigMap オブジェクトで prometheus と呼ばれています。

2.6. ノードセレクターを使用したモニタリングコンポーネントの移動

ラベル付きノードで nodeSelector 制約を使用すると、任意のモニタリングスタックコンポーネントを特定ノードに移動できます。これにより、クラスター全体のモニタリングコンポーネントの配置と分散を制御できます。

モニタリングコンポーネントの配置と分散を制御することで、システムリソースの使用を最適化し、パフォーマンスを高め、特定の要件やポリシーに基づいてワークロードを分離できます。

2.6.1. ノードセレクターと他の制約の連携

ノードセレクターの制約を使用してモニタリングコンポーネントを移動する場合、クラスターに Pod のスケジューリングを制御するための他の制約があることに注意してください。

- Pod の配置を制御するために、トポロジー分散制約が設定されている可能性があります。

- Prometheus、Thanos Querier、Alertmanager、およびその他のモニタリングコンポーネントでは、コンポーネントの複数の Pod が必ず異なるノードに分散されて高可用性が常に確保されるように、ハードな非アフィニティールールが設定されています。

ノード上で Pod をスケジュールする場合、Pod スケジューラーは既存の制約をすべて満たすように Pod の配置を決定します。つまり、Pod スケジューラーがどの Pod をどのノードに配置するかを決定する際に、すべての制約が組み合わされます。

そのため、ノードセレクター制約を設定しても既存の制約をすべて満たすことができない場合、Pod スケジューラーはすべての制約をマッチさせることができず、ノードへの Pod 配置をスケジュールしません。

モニタリングコンポーネントの耐障害性と高可用性を維持するには、コンポーネントを移動するノードセレクター制約を設定する際に、十分な数のノードが利用可能で、すべての制約がマッチすることを確認してください。

2.6.2. モニタリングコンポーネントの異なるノードへの移動

モニタリングスタックコンポーネントが実行されるクラスター内のノードを指定するには、ノードに割り当てられたラベルと一致するようにコンポーネントの ConfigMap オブジェクトの nodeSelector 制約を設定します。

ノードセレクター制約を既存のスケジュール済み Pod に直接追加することはできません。

前提条件

OpenShift Container Platform のコアモニタリングコンポーネントを設定する場合、以下を実行します。

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。

-

ユーザー定義のプロジェクトをモニターするコンポーネントを設定する場合:

-

cluster-adminクラスターロールを持つユーザーとして、またはopenshift-user-workload-monitoringプロジェクトのuser-workload-monitoring-config-editロールを持つユーザーとして、クラスターにアクセスできる。 -

user-workload-monitoring-configConfigMapオブジェクトを作成している。

-

-

OpenShift CLI (

oc) がインストールされている。

手順

まだの場合は、モニタリングコンポーネントを実行するノードにラベルを追加します。

oc label nodes <node-name> <node-label>

$ oc label nodes <node-name> <node-label>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ConfigMapオブジェクトを編集します。OpenShift Container Platform のコアプロジェクトをモニターするコンポーネントを移行するには、以下を実行します。

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yamlでコンポーネントのnodeSelector制約のノードラベルを指定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記nodeSelectorの制約を設定した後もモニタリングコンポーネントがPending状態のままになっている場合は、Pod イベントでテイントおよび容認に関連するエラーの有無を確認します。

ユーザー定義プロジェクトをモニターするコンポーネントを移動するには、以下を実行します。

openshift-user-workload-monitoringプロジェクトでuser-workload-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yamlでコンポーネントのnodeSelector制約のノードラベルを指定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記nodeSelectorの制約を設定した後もモニタリングコンポーネントがPending状態のままになっている場合は、Pod イベントでテイントおよび容認に関連するエラーの有無を確認します。

変更を適用するためにファイルを保存します。新しい設定で指定されたコンポーネントは、新しいノードに自動的に移動されます。

注記user-workload-monitoring-configConfigMapオブジェクトに適用される設定は、クラスター管理者がユーザー定義プロジェクトのモニタリングを有効にしない限りアクティブにされません。警告monitoring config map への変更を保存すると、プロジェクトの Pod およびその他のリソースが再デプロイされる場合があります。そのプロジェクトで実行中のモニタリングプロセスも再起動する場合があります。

2.7. モニタリングコンポーネントへの容認 (Toleration) の割り当て

容認をモニタリングスタックのコンポーネントに割り当て、それらをテイントされたノードに移動することができます。

前提条件

OpenShift Container Platform のコアモニタリングコンポーネントを設定する場合、以下を実行します。

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。

-

ユーザー定義のプロジェクトをモニターするコンポーネントを設定する場合:

-

cluster-adminクラスターロールを持つユーザーとして、またはopenshift-user-workload-monitoringプロジェクトのuser-workload-monitoring-config-editロールを持つユーザーとして、クラスターにアクセスできる。 -

user-workload-monitoring-configConfigMapオブジェクトを作成している。

-

-

OpenShift CLI (

oc) がインストールされている。

手順

ConfigMapオブジェクトを編集します。容認をコア OpenShift Container Platform プロジェクトをモニターするコンポーネントに割り当てるには、以下を実行します。

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンポーネントの

tolerationsを指定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow <component>および<toleration_specification>を随時置き換えます。たとえば、

oc adm taint nodes node1 key1=value1:NoScheduleは、キーがkey1で、値がvalue1のnode1にテイントを追加します。これにより、モニタリングコンポーネントがnode1に Pod をデプロイするのを防ぎます。ただし、そのテイントに対して許容値が設定されている場合を除きます。以下の例は、サンプルのテイントを容認するようにalertmanagerMainコンポーネントを設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

ユーザー定義プロジェクトをモニターするコンポーネントに容認を割り当てるには、以下を実行します。

openshift-user-workload-monitoringプロジェクトでuser-workload-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンポーネントの

tolerationsを指定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow <component>および<toleration_specification>を随時置き換えます。たとえば、

oc adm taint nodes node1 key1=value1:NoScheduleは、キーがkey1で、値がvalue1のnode1にテイントを追加します。これにより、モニタリングコンポーネントがnode1に Pod をデプロイするのを防ぎます。ただし、そのテイントに対して許容値が設定されている場合を除きます。以下の例では、サンプルのテイントを容認するようにthanosRulerコンポーネントを設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

変更を適用するためにファイルを保存します。新しいコンポーネントの配置設定が自動的に適用されます。

注記user-workload-monitoring-configConfigMapオブジェクトに適用される設定は、クラスター管理者がユーザー定義プロジェクトのモニタリングを有効にしない限りアクティブにされません。警告変更がモニタリング設定マップに保存されると、関連するプロジェクトの Pod およびその他のリソースが再デプロイされる可能性があります。該当するプロジェクトの実行中のモニタリングプロセスも再起動する可能性があります。

2.8. 専用サービスモニターの設定

専用のサービスモニターを使用してリソースメトリックパイプラインのメトリックを収集するように OpenShift Container Platform コアプラットフォームモニタリングを設定できます。

専用サービスモニターを有効にすると、kubelet エンドポイントから 2 つの追加メトリクスが公開され、honorTimestamps フィールドの値が true に設定されます。

専用のサービスモニターを有効にすることで、oc adm top pod コマンドや horizontal Pod Autoscaler などで使用される Prometheus Adapter ベースの CPU 使用率測定の一貫性を向上させることができます。

2.8.1. 専用サービスモニターの有効化

openshift-monitoring namespace の cluster-monitoring-config ConfigMap オブジェクトで dedicatedServiceMonitors キーを設定することで、専用サービスモニターを使用するようにコアプラットフォームのモニタリングを設定できます。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。

手順

openshift-monitoringnamespace でcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のサンプルに示すように、

enabled: trueのキーと値のペアを追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- kubelet

/metrics/resourceエンドポイントを公開する専用サービスモニターをデプロイするには、enabledフィールドの値をtrueに設定します。

ファイルを保存して、変更を自動的に適用します。

警告cluster-monitoring-config設定マップへの変更を保存すると、openshift-monitoringプロジェクトの Pod およびその他のリソースが再デプロイされる場合があります。そのプロジェクトで実行中のモニタリングプロセスも再起動する場合があります。

2.9. Configuring persistent storage

クラスターモニタリングを永続ストレージと共に実行すると、メトリクスは永続ボリューム (PV) に保存され、Pod の再起動または再作成後も維持されます。これは、メトリクスデータまたはアラートデータをデータ損失から保護する必要がある場合に適しています。実稼働環境では、永続ストレージを設定することを強く推奨します。IO デマンドが高いため、ローカルストレージを使用することが有利になります。

設定可能な推奨のストレージ技術 を参照してください。

2.9.1. 永続ストレージの前提条件

- ディスクが一杯にならないように、十分なローカル永続ストレージを確保します。必要な永続ストレージは Pod 数によって異なります。永続ストレージのシステム要件については、Prometheus データベースのストレージ要件 を参照してください。

- 永続ボリューム要求 (PVC) で要求される永続ボリューム (PV) が利用できる状態にあることを確認する必要があります。各レプリカに 1 つの PV が必要です。Prometheus と Alertmanager の両方に 2 つのレプリカがあるため、モニタリングスタック全体をサポートするには 4 つの PV が必要です。PV はローカルストレージ Operator から入手できますが、動的にプロビジョニングされるストレージが有効にされている場合は利用できません。

-

永続ボリュームを設定する際に、

volumeModeパラメーターのストレージタイプ値としてFilesystemを使用します。 - 注記

永続ストレージにローカルボリュームを使用する場合は、

LocalVolumeオブジェクトのvolumeMode: Blockで記述される raw ブロックボリュームを使用しないでください。Prometheus は raw ブロックボリュームを使用できません。重要Prometheus は、POSIX に準拠していないファイルシステムをサポートしません。たとえば、一部の NFS ファイルシステム実装は POSIX に準拠していません。ストレージに NFS ファイルシステムを使用する場合は、NFS 実装が完全に POSIX に準拠していることをベンダーに確認してください。

2.9.2. ローカ永続ボリューム要求 (PVC) の設定

モニタリングコンポーネントが永続ボリューム (PV) を使用できるようにするには、永続ボリューム要求 (PVC) を設定する必要があります。

前提条件

OpenShift Container Platform のコアモニタリングコンポーネントを設定する場合、以下を実行します。

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。

-

ユーザー定義のプロジェクトをモニターするコンポーネントを設定する場合:

-

cluster-adminクラスターロールを持つユーザーとして、またはopenshift-user-workload-monitoringプロジェクトのuser-workload-monitoring-config-editロールを持つユーザーとして、クラスターにアクセスできる。 -

user-workload-monitoring-configConfigMapオブジェクトを作成している。

-

-

OpenShift CLI (

oc) がインストールされている。

手順

ConfigMapオブジェクトを編集します。OpenShift Container Platform のコアプロジェクトをモニターするコンポーネントの PVC を設定するには、以下を実行します。

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンポーネントの PVC 設定を

data/config.yamlの下に追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow volumeClaimTemplateの指定方法については、PersistentVolumeClaims についての Kubernetes ドキュメント を参照してください。以下の例では、OpenShift Container Platform のコアコンポーネントをモニターする Prometheus インスタンスのローカル永続ストレージを要求する PVC を設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 上記の例では、ローカルストレージ Operator によって作成されるストレージクラスは

local-storageと呼ばれます。以下の例では、Alertmanager のローカル永続ストレージを要求する PVC を設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

ユーザー定義プロジェクトをモニターするコンポーネントの PVC を設定するには、以下を実行します。

openshift-user-workload-monitoringプロジェクトでuser-workload-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンポーネントの PVC 設定を

data/config.yamlの下に追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow volumeClaimTemplateの指定方法については、PersistentVolumeClaims についての Kubernetes ドキュメント を参照してください。以下の例では、ユーザー定義プロジェクトをモニターする Prometheus インスタンスのローカル永続ストレージを要求する PVC を設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 上記の例では、ローカルストレージ Operator によって作成されるストレージクラスは

local-storageと呼ばれます。以下の例では、Thanos Ruler のローカル永続ストレージを要求する PVC を設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記thanosRulerコンポーネントのストレージ要件は、評価されルールの数や、各ルールが生成するサンプル数により異なります。

変更を適用するためにファイルを保存します。新規設定の影響を受けた Pod は自動的に再起動され、新規ストレージ設定が適用されます。

注記user-workload-monitoring-configConfigMapオブジェクトに適用される設定は、クラスター管理者がユーザー定義プロジェクトのモニタリングを有効にしない限りアクティブにされません。警告変更がモニタリング設定マップに保存されると、関連するプロジェクトの Pod およびその他のリソースが再デプロイされる可能性があります。該当するプロジェクトの実行中のモニタリングプロセスも再起動する可能性があります。

2.9.3. 永続ストレージボリュームのサイズ変更

OpenShift Container Platform は、使用される基礎となる StorageClass リソースが永続的なボリュームのサイズ変更をサポートしている場合でも、StatefulSet リソースによって使用される既存の永続的なストレージボリュームのサイズ変更をサポートしません。したがって、既存の永続ボリューム要求 (PVC) の storage フィールドをより大きなサイズで更新しても、この設定は関連する永続ボリューム (PV) に反映されません。

ただし、手動プロセスを使用して PV のサイズを変更することは可能です。Prometheus、Thanos Ruler、Alertmanager などの監視コンポーネントの PV のサイズを変更する場合は、コンポーネントが設定されている適切な設定マップを更新できます。次に、PVC にパッチを適用し、Pod を削除して孤立させます。Pod を孤立させると、StatefulSet リソースがすぐに再作成され、Pod にマウントされたボリュームのサイズが新しい PVC 設定で自動的に更新されます。このプロセス中にサービスの中断は発生しません。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 OpenShift Container Platform のコアモニタリングコンポーネントを設定する場合、以下を実行します。

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。 - コア OpenShift Container Platform モニタリングコンポーネント用に少なくとも 1 つの PVC を設定しました。

-

ユーザー定義のプロジェクトをモニターするコンポーネントを設定する場合:

-

cluster-adminクラスターロールを持つユーザーとして、またはopenshift-user-workload-monitoringプロジェクトのuser-workload-monitoring-config-editロールを持つユーザーとして、クラスターにアクセスできる。 -

user-workload-monitoring-configConfigMapオブジェクトを作成している。 - ユーザー定義プロジェクトを監視するコンポーネント用に少なくとも 1 つの PVC を設定しました。

-

手順

ConfigMapオブジェクトを編集します。OpenShift Container Platform のコアプロジェクトをモニターするコンポーネントの PVC サイズを変更するには、以下を実行します。

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yamlの下に、コンポーネントの PVC 設定用の新しいストレージサイズを追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例では、コア OpenShift Container Platform コンポーネントをモニターする Prometheus インスタンスのローカル永続ストレージを 100 ギガバイトに設定する PVC を設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次の例では、Alertmanager のローカル永続ストレージを 40 ギガバイトに設定する PVC を設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

ユーザー定義プロジェクトを監視するコンポーネントの PVC のサイズを変更するには:

注記ユーザー定義のプロジェクトを監視する Thanos Ruler および Prometheus インスタンスのボリュームサイズを変更できます。

openshift-user-workload-monitoringプロジェクトでuser-workload-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yaml下の監視コンポーネントの PVC 設定を更新します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次の例では、ユーザー定義のプロジェクトを監視する Prometheus インスタンスの PVC サイズを 100 ギガバイトに設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次の例では、Thanos Ruler の PVC サイズを 20 ギガバイトに設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記thanosRulerコンポーネントのストレージ要件は、評価されルールの数や、各ルールが生成するサンプル数により異なります。

変更を適用するためにファイルを保存します。新規設定の影響を受けた Pod は自動的に再起動します。

警告monitoring config map への変更を保存すると、関連プロジェクトの Pod およびその他のリソースが再デプロイされる場合があります。そのプロジェクトで実行している監視プロセスも再開される可能性があります。

更新されたストレージ要求を使用して、すべての PVC に手動でパッチを適用します。以下の例では、

openshift-monitoringnamespace の Prometheus コンポーネントのストレージサイズを 100Gi に変更します。for p in $(oc -n openshift-monitoring get pvc -l app.kubernetes.io/name=prometheus -o jsonpath='{range .items[*]}{.metadata.name} {end}'); do \ oc -n openshift-monitoring patch pvc/${p} --patch '{"spec": {"resources": {"requests": {"storage":"100Gi"}}}}'; \ done$ for p in $(oc -n openshift-monitoring get pvc -l app.kubernetes.io/name=prometheus -o jsonpath='{range .items[*]}{.metadata.name} {end}'); do \ oc -n openshift-monitoring patch pvc/${p} --patch '{"spec": {"resources": {"requests": {"storage":"100Gi"}}}}'; \ doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow --cascade=orphanパラメーターを使用して、基になる StatefulSet を削除します。oc delete statefulset -l app.kubernetes.io/name=prometheus --cascade=orphan

$ oc delete statefulset -l app.kubernetes.io/name=prometheus --cascade=orphanCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.9.4. Prometheus メトリクスデータの保持期間の変更

デフォルトで、OpenShift Container Platform クラスターモニタリングスタックは、Prometheus データの保持期間を 15 日間に設定します。この保持期間は、データ削除のタイミングを調整するために変更できます。

前提条件

OpenShift Container Platform のコアモニタリングコンポーネントを設定する場合、以下を実行します。

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。

-

ユーザー定義のプロジェクトをモニターするコンポーネントを設定する場合:

-

cluster-adminロールを持つユーザーとして、またはopenshift-user-workload-monitoringプロジェクトのuser-workload-monitoring-config-editロールを持つユーザーとして、クラスターにアクセスできる。 -

user-workload-monitoring-configConfigMapオブジェクトを作成している。

-

-

OpenShift CLI (

oc) がインストールされている。

手順

ConfigMapオブジェクトを編集します。OpenShift Container Platform のコアプロジェクトをモニターする Prometheus インスタンスの保持時間を変更するには、以下を実行します。

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 保持期間の設定を

data/config.yamlに追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow <time_specification>を、ms(ミリ秒)、s(秒)、m(分)、h(時間)、d(日)、w(週)、またはy(年) が直後に続く数字に置き換えます。以下の例では、OpenShift Container Platform のコアコンポーネントをモニターする Prometheus インスタンスの保持期間を 24 時間に設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

ユーザー定義のプロジェクトをモニターする Prometheus インスタンスの保持時間を変更するには、以下を実行します。

openshift-user-workload-monitoringプロジェクトでuser-workload-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 保持期間の設定を

data/config.yamlに追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow <time_specification>を、ms(ミリ秒)、s(秒)、m(分)、h(時間)、d(日)、w(週)、またはy(年) が直後に続く数字に置き換えます。以下の例では、ユーザー定義プロジェクトをモニターする Prometheus インスタンスの保持期間を 24 時間に設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

変更を適用するためにファイルを保存します。新規設定の影響を受けた Pod は自動的に再起動されます。

注記user-workload-monitoring-configConfigMapオブジェクトに適用される設定は、クラスター管理者がユーザー定義プロジェクトのモニタリングを有効にしない限りアクティブにされません。警告変更がモニタリング設定マップに保存されると、関連するプロジェクトの Pod およびその他のリソースが再デプロイされる可能性があります。該当するプロジェクトの実行中のモニタリングプロセスも再起動する可能性があります。

2.9.5. Thanos Ruler メトリクスデータの保持期間の変更

デフォルトでは、ユーザー定義のプロジェクトでは、Thanos Ruler は 24 時間にわたりメトリクスデータを自動的に保持します。openshift-user-workload-monitoring namespace の user-workload-monitoring-config の Config Map に時間の値を指定して、このデータの保持期間を変更できます。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 - クラスター管理者は、ユーザー定義プロジェクトのモニタリングを有効にしている。

-

cluster-adminクラスターロールを持つユーザーとして、またはopenshift-user-workload-monitoringプロジェクトのuser-workload-monitoring-config-editロールを持つユーザーとして、クラスターにアクセスできる。 -

user-workload-monitoring-configConfigMapオブジェクトを作成している。

監視設定マップの変更を保存すると、監視プロセスが再起動し、関連プロジェクトの Pod やその他のリソースが再デプロイされる場合があります。そのプロジェクトで実行中のモニタリングプロセスも再起動する場合があります。

手順

openshift-user-workload-monitoringプロジェクトでuser-workload-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 保持期間の設定を

data/config.yamlに追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 保持時間 は、

ms(ミリ秒)、s(秒)、m(分)、h(時)、d(日)、w(週)、y(年) が直後に続く数字で指定します。1h30m15sなどの特定の時間に時間値を組み合わせることもできます。デフォルトは24hです。

以下の例では、Thanos Ruler データの保持期間を 10 日間に設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を適用するためにファイルを保存します。新規設定が加えられた Pod は自動的に再起動します。

2.10. リモート書き込みストレージの設定

リモート書き込みストレージを設定して、Prometheus が取り込んだメトリックをリモートシステムに送信して長期保存できるようにします。これを行っても、Prometheus がメトリクスを保存する方法や期間には影響はありません。

前提条件

OpenShift Container Platform のコアモニタリングコンポーネントを設定する場合、以下を実行します。

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。

-

ユーザー定義のプロジェクトをモニターするコンポーネントを設定する場合:

-

cluster-adminクラスターロールを持つユーザーとして、またはopenshift-user-workload-monitoringプロジェクトのuser-workload-monitoring-config-editロールを持つユーザーとして、クラスターにアクセスできる。 -

user-workload-monitoring-configConfigMapオブジェクトを作成している。

-

-

OpenShift CLI (

oc) がインストールされている。 - リモート書き込み互換性のあるエンドポイント (Thanos) を設定し、エンドポイント URL を把握している。リモート書き込み機能と互換性のないエンドポイントの情報ては、Prometheus リモートエンドポイントおよびストレージについてのドキュメント を参照してください。

リモート書き込みエンドポイントに認証情報を設定している。

Importantセキュリティーリスクを軽減するには、暗号化されていない HTTP を使用するか、認証を使用せずに、エンドポイントにメトリックを送信しないようにします。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

data/config.yaml/prometheusK8sにremoteWrite:セクションを追加します。 このセクションにエンドポイント URL および認証情報を追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow endpoint_authentication_credentialsの場合には、エンドポイントの認証情報を置き換えます。現時点で、サポートされている認証方法は Basic 認証 (basicAuth) およびクライアント TLS(tlsConfig) 認証です。以下の例では、Basic 認証を設定します。

basicAuth: username: <usernameSecret> password: <passwordSecret>basicAuth: username: <usernameSecret> password: <passwordSecret>Copy to Clipboard Copied! Toggle word wrap Toggle overflow <usernameSecret>および<passwordSecret>は随時置き換えます。以下の例では、

nameにremoteWriteAuth、keyにuserとpasswordを指定した Basic 認証です。これらの値には、エンドポイント認証情報が含まれます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例では、クライアント TLS 認証を設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow それに応じて、

<caSecret>、<certSecret>および<keySecret>を置き換えます。以下の例では、

name値にselfsigned-mtls-bundle、cakey値にca.crt、certkey値にclient.crt、keySecretkey値にclient.keyを使用した TLS 認証設定を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

認証クレデンシャルの後に、書き込みの再ラベル設定値を追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow <write_relabel_configs>は、リモートエンドポイントに送信する必要のあるメトリクスの書き込みラベル一覧に置き換えます。以下の例では、

my_metricという単一のメトリックを転送する方法を紹介します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 書き込み再ラベル設定オプションについては、Prometheus relabel_config documentation を参照してください。

必要な場合は、以下のように

nameおよびnamespacemetadataの値を変更して、ユーザー定義のプロジェクトをモニターする Prometheus インスタンスのリモート書き込みを設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記Prometheus 設定マップコンポーネントは、

cluster-monitoring-configConfigMapオブジェクトでprometheusK8sと呼ばれ、user-workload-monitoring-configConfigMapオブジェクトでprometheusと呼ばれます。ファイルを保存して、変更を

ConfigMapオブジェクトに適用します。新規設定の影響を受けた Pod は自動的に再起動します。注記user-workload-monitoring-configConfigMapオブジェクトに適用される設定は、クラスター管理者がユーザー定義プロジェクトのモニタリングを有効にしない限りアクティブにされません。警告モニタリング

ConfigMapオブジェクトへの変更を保存すると、関連するプロジェクトの Pod およびその他のリソースが再デプロイされる可能性があります。また、変更を保存すると、そのプロジェクトで実行中のモニタリングプロセスも再起動する可能性があります。

2.11. ユーザー定義プロジェクトでバインドされていないメトリクス属性の影響の制御

開発者は、キーと値のペアの形式でメトリクスの属性を定義するためにラベルを作成できます。使用できる可能性のあるキーと値のペアの数は、属性について使用できる可能性のある値の数に対応します。数が無制限の値を持つ属性は、バインドされていない属性と呼ばれます。たとえば、customer_id 属性は、使用できる値が無限にあるため、バインドされていない属性になります。

割り当てられるキーと値のペアにはすべて、一意の時系列があります。ラベルに多数のバインドされていない値を使用すると、作成される時系列の数が指数関数的に増加する可能性があります。これは Prometheus のパフォーマンスに影響する可能性があり、多くのディスク領域を消費する可能性があります。

クラスター管理者は、以下の手段を使用して、ユーザー定義プロジェクトでのバインドされていないメトリクス属性の影響を制御できます。

- ユーザー定義プロジェクトで、ターゲット収集ごとに 受け入れ可能なサンプル数を制限 します。

- ターゲットを収集できない場合や、収集サンプルのしきい値に達する際に実行される アラートを作成 します。

収集サンプルを制限すると、多くのバインドされていない属性をラベルに追加して問題が発生するのを防ぐことができます。さらに開発者は、メトリクスに定義するバインドされていない属性の数を制限することにより、根本的な原因を防ぐことができます。使用可能な値の制限されたセットにバインドされる属性を使用すると、可能なキーと値のペアの組み合わせの数が減ります。

2.11.1. ユーザー定義プロジェクトの収集サンプル制限の設定

ユーザー定義プロジェクトで、ターゲット収集ごとに受け入れ可能なサンプル数を制限できます。

サンプル制限を設定すると、制限に達した後にそのターゲット収集についての追加のサンプルデータは取り込まれません。

前提条件

-

cluster-adminロールを持つユーザーとして、またはopenshift-user-workload-monitoringプロジェクトのuser-workload-monitoring-config-editロールを持つユーザーとして、クラスターにアクセスできる。 -

user-workload-monitoring-configConfigMapオブジェクトを作成している。 -

OpenShift CLI (

oc) がインストールされている。

手順

openshift-user-workload-monitoringプロジェクトでuser-workload-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow enforcedSampleLimit設定をdata/config.yamlに追加し、ユーザー定義プロジェクトのターゲットの収集ごとに受け入れ可能なサンプルの数を制限できます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- このパラメーターが指定されている場合は、値が必要です。この

enforcedSampleLimitの例では、ユーザー定義プロジェクトのターゲット収集ごとに受け入れ可能なサンプル数を 50,000 に制限します。

変更を適用するためにファイルを保存します。制限は自動的に適用されます。

注記user-workload-monitoring-configConfigMapオブジェクトに適用される設定は、クラスター管理者がユーザー定義プロジェクトのモニタリングを有効にしない限りアクティブにされません。警告変更が

user-workload-monitoring-configConfigMapオブジェクトに保存されると、openshift-user-workload-monitoringプロジェクトの Pod および他のリソースは再デプロイされる可能性があります。該当するプロジェクトの実行中のモニタリングプロセスも再起動する可能性があります。

2.11.2. 収集サンプルアラートの作成

以下の場合に通知するアラートを作成できます。

-

ターゲットを収集できず、指定された

forの期間利用できない -

指定された

forの期間、収集サンプルのしきい値に達するか、この値を上回る

前提条件

-

cluster-adminクラスターロールを持つユーザーとして、またはopenshift-user-workload-monitoringプロジェクトのuser-workload-monitoring-config-editロールを持つユーザーとして、クラスターにアクセスできる。 - ユーザー定義プロジェクトのモニタリングを有効にしている。

-

user-workload-monitoring-configConfigMapオブジェクトを作成している。 -

enforcedSampleLimitを使用して、ユーザー定義プロジェクトのターゲット収集ごとに受け入れ可能なサンプル数を制限している。 -

OpenShift CLI (

oc) がインストールされている。

手順

ターゲットがダウンし、実行されたサンプル制限に近づく際に通知するアラートを指定して YAML ファイルを作成します。この例のファイルは

monitoring-stack-alerts.yamlという名前です。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- アラートルールの名前を定義します。

- 2

- アラートルールをデプロイするユーザー定義のプロジェクトを指定します。

- 3

TargetDownアラートは、forの期間にターゲットを収集できないか、利用できない場合に実行されます。- 4

TargetDownアラートが実行される場合に出力されるメッセージ。- 5

- アラートが実行される前に、

TargetDownアラートの条件がこの期間中 true である必要があります。 - 6

TargetDownアラートの重大度を定義します。- 7

ApproachingEnforcedSamplesLimitアラートは、指定されたforの期間に定義された収集サンプルのしきい値に達するか、この値を上回る場合に実行されます。- 8

ApproachingEnforcedSamplesLimitアラートの実行時に出力されるメッセージ。- 9

ApproachingEnforcedSamplesLimitアラートのしきい値。この例では、ターゲット収集ごとのサンプル数が実行されたサンプル制限50000の 80% を超えるとアラートが実行されます。アラートが実行される前に、forの期間も経過している必要があります。式scrape_samples_scraped/<number> > <threshold>の<number>はuser-workload-monitoring-configConfigMapオブジェクトで定義されるenforcedSampleLimit値に一致する必要があります。- 10

- アラートが実行される前に、

ApproachingEnforcedSamplesLimitアラートの条件がこの期間中 true である必要があります。 - 11

ApproachingEnforcedSamplesLimitアラートの重大度を定義します。

設定をユーザー定義プロジェクトに適用します。

oc apply -f monitoring-stack-alerts.yaml

$ oc apply -f monitoring-stack-alerts.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第3章 外部 alertmanager インスタンスの設定

OpenShift Container Platform モニタリングスタックには、Prometheus からのアラートのルートなど、ローカルの Alertmanager インスタンスが含まれます。openshift-monitoring または user-workload-monitoring-config プロジェクトのいずれかで cluster-monitoring-config 設定マップを設定して外部 Alertmanager インスタンスを追加できます。

複数のクラスターに同じ外部 Alertmanager 設定を追加し、クラスターごとにローカルインスタンスを無効にする場合には、単一の外部 Alertmanager インスタンスを使用して複数のクラスターのアラートルーティングを管理できます。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 openshift-monitoringプロジェクトで OpenShift Container Platform のコアモニタリングコンポーネントを設定する場合:-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

cluster-monitoring-configConfigMap を作成している。

-

ユーザー定義のプロジェクトをモニターするコンポーネントを設定する場合:

-

cluster-adminクラスターロールを持つユーザーとして、またはopenshift-user-workload-monitoringプロジェクトのuser-workload-monitoring-config-editロールを持つユーザーとして、クラスターにアクセスできる。 -

user-workload-monitoring-configConfigMap オブジェクトを作成している。

-

手順

ConfigMapオブジェクトを編集します。OpenShift Container Platform のコアプロジェクトのルーティングアラート用に追加の Alertmanager を設定するには、以下を実行します。

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMap を編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

data/config.yaml/prometheusK8sにadditionalAlertmanagerConfigs:セクションを追加します。 このセクションに別の Alertmanager 設定の詳細情報を追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow <alertmanager_specification>は、追加の Alertmanager インスタンスの認証およびその他の設定の詳細を置き換えます。現時点で、サポートされている認証方法はベアラートークン (bearerToken) およびクライアント TLS(tlsConfig) です。以下の設定マップは、クライアント TLS 認証でベアラートークンを使用して追加の Alertmanager を設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

ユーザー定義プロジェクトでルーティングアラート用に追加の Alertmanager インスタンスを設定するには、以下を実行します。

openshift-user-workload-monitoringプロジェクトでuser-workload-monitoring-config設定マップを編集します。oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

data/config.yaml/の下に<component>/additionalAlertmanagerConfigs:セクションを追加します。 このセクションに別の Alertmanager 設定の詳細情報を追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow <component>には、サポート対象の外部 Alertmanager コンポーネント (prometheusまたはthanosRuler)2 つの内、いずれかに置き換えます。<alertmanager_specification>は、追加の Alertmanager インスタンスの認証およびその他の設定の詳細を置き換えます。現時点で、サポートされている認証方法はベアラートークン (bearerToken) およびクライアント TLS(tlsConfig) です。以下の設定マップは、ベアラートークンおよびクライアント TLS 認証を指定した Thanos Ruler を使用して追加の Alertmanager を設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記user-workload-monitoring-configConfigMapオブジェクトに適用される設定は、クラスター管理者がユーザー定義プロジェクトのモニタリングを有効にしない限りアクティブにされません。

-

ファイルを保存して、変更を

ConfigMapオブジェクトに適用します。新しいコンポーネントの配置設定が自動的に適用されます。

3.1. 追加ラベルの時系列 (time series) およびアラートへの割り当て

Prometheus の外部ラベル機能を使用して、カスタムラベルを、Prometheus から出るすべての時系列およびアラートに割り当てることができます。

前提条件

OpenShift Container Platform のコアモニタリングコンポーネントを設定する場合、以下を実行します。

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。

-

ユーザー定義のプロジェクトをモニターするコンポーネントを設定する場合:

-

cluster-adminクラスターロールを持つユーザーとして、またはopenshift-user-workload-monitoringプロジェクトのuser-workload-monitoring-config-editロールを持つユーザーとして、クラスターにアクセスできる。 -

user-workload-monitoring-configConfigMapオブジェクトを作成している。

-

-

OpenShift CLI (

oc) がインストールされている。

手順

ConfigMapオブジェクトを編集します。カスタムラベルを、OpenShift Container Platform のコアプロジェクトをモニターする Prometheus インスタンスから出るすべての時系列およびアラートに割り当てるには、以下を実行します。

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yamlの下にすべてのメトリクスについて追加する必要のあるラベルのマップを定義します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<key>: <value>をキーと値のペアのマップに置き換えます。ここで、<key>は新規ラベルの一意の名前で、<value>はその値になります。

警告prometheusまたはprometheus_replicaは予約され、上書きされるため、これらをキー名として使用しないでください。たとえば、リージョンおよび環境に関するメタデータをすべての時系列およびアラートに追加するには、以下を使用します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

カスタムラベルを、ユーザー定義のプロジェクトをモニターする Prometheus インスタンスから出るすべての時系列およびアラートに割り当てるには、以下を実行します。

openshift-user-workload-monitoringプロジェクトでuser-workload-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yamlの下にすべてのメトリクスについて追加する必要のあるラベルのマップを定義します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<key>: <value>をキーと値のペアのマップに置き換えます。ここで、<key>は新規ラベルの一意の名前で、<value>はその値になります。

警告prometheusまたはprometheus_replicaは予約され、上書きされるため、これらをキー名として使用しないでください。注記openshift-user-workload-monitoringプロジェクトでは、Prometheus はメトリクスを処理し、Thanos Ruler はアラートおよび記録ルールを処理します。user-workload-monitoring-configConfigMapオブジェクトでprometheusのexternalLabelsを設定すると、すべてのルールではなく、メトリクスの外部ラベルのみが設定されます。たとえば、リージョンおよび環境に関するメタデータをすべての時系列およびユーザー定義プロジェクトに関連するアラートに追加するには、以下を使用します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

変更を適用するためにファイルを保存します。新しい設定は自動的に適用されます。

注記user-workload-monitoring-configConfigMapオブジェクトに適用される設定は、クラスター管理者がユーザー定義プロジェクトのモニタリングを有効にしない限りアクティブにされません。警告変更がモニタリング設定マップに保存されると、関連するプロジェクトの Pod およびその他のリソースが再デプロイされる可能性があります。該当するプロジェクトの実行中のモニタリングプロセスも再起動する可能性があります。

3.2. モニタリングコンポーネントのログレベルの設定

Alertmanager、Prometheus Operator、Prometheus、Alertmanager および Thanos Querier および Thanos Ruler のログレベルを設定できます。

cluster-monitoring-config および user-workload-monitoring-configConfigMap オブジェクトの該当するコンポーネントには、以下のログレベルを適用することができます。

-

debug:デバッグ、情報、警告、およびエラーメッセージをログに記録します。 -

info:情報、警告およびエラーメッセージをログに記録します。 -

warn:警告およびエラーメッセージのみをログに記録します。 -

error:エラーメッセージのみをログに記録します。

デフォルトのログレベルは info です。

前提条件

openshift-monitoringプロジェクトで Alertmanager、Prometheus Operator、Prometheus、または Thanos Querier のログレベルを設定する場合には、以下を実行します。-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。

-

openshift-user-workload-monitoringプロジェクトで Prometheus Operator、Prometheus、または Thanos Ruler のログレベルを設定する場合には、以下を実行します。-

cluster-adminクラスターロールを持つユーザーとして、またはopenshift-user-workload-monitoringプロジェクトのuser-workload-monitoring-config-editロールを持つユーザーとして、クラスターにアクセスできる。 -

user-workload-monitoring-configConfigMapオブジェクトを作成している。

-

-

OpenShift CLI (

oc) がインストールされている。

手順

ConfigMapオブジェクトを編集します。openshift-monitoringプロジェクトのコンポーネントのログレベルを設定するには、以下を実行します。openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンポーネントの

logLevel: <log_level>をdata/config.yamlの下に追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

openshift-user-workload-monitoringプロジェクトのコンポーネントのログレベルを設定するには、以下を実行します。openshift-user-workload-monitoringプロジェクトでuser-workload-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンポーネントの

logLevel: <log_level>をdata/config.yamlの下に追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

変更を適用するためにファイルを保存します。ログレベルの変更を適用する際に、コンポーネントの Pod は自動的に再起動します。

注記user-workload-monitoring-configConfigMapオブジェクトに適用される設定は、クラスター管理者がユーザー定義プロジェクトのモニタリングを有効にしない限りアクティブにされません。警告変更がモニタリング設定マップに保存されると、関連するプロジェクトの Pod およびその他のリソースが再デプロイされる可能性があります。該当するプロジェクトの実行中のモニタリングプロセスも再起動する可能性があります。

関連するプロジェクトでデプロイメントまたは Pod 設定を確認し、ログレベルが適用されていることを確認します。以下の例では、

openshift-user-workload-monitoringプロジェクトのprometheus-operatorデプロイメントでログレベルを確認します。oc -n openshift-user-workload-monitoring get deploy prometheus-operator -o yaml | grep "log-level"

$ oc -n openshift-user-workload-monitoring get deploy prometheus-operator -o yaml | grep "log-level"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

- --log-level=debug

- --log-level=debugCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンポーネントの Pod が実行中であることを確認します。以下の例は、

openshift-user-workload-monitoringプロジェクトの Pod のステータスを一覧表示します。oc -n openshift-user-workload-monitoring get pods

$ oc -n openshift-user-workload-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記認識されない

loglevel値がConfigMapオブジェクトに含まれる場合は、コンポーネントの Pod が正常に再起動しない可能性があります。

3.3. Prometheus のクエリーログファイルの有効化

エンジンによって実行されたすべてのクエリーをログファイルに書き込むように Prometheus を設定できます。これは、デフォルトのプラットフォームモニタリングおよびユーザー定義のワークロードモニタリングに対して行うことができます。

ログローテーションはサポートされていないため、問題のトラブルシューティングが必要な場合にのみ、この機能を一時的に有効にします。トラブルシューティングが終了したら、ConfigMapオブジェクトに加えた変更を元に戻してクエリーログを無効にし、機能を有効にします。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 openshift-monitoringプロジェクトで Prometheus のクエリーログファイル機能を有効にしている場合:-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。

-

openshift-user-workload-monitoringプロジェクトで Prometheus のクエリーログファイル機能を有効にしている場合:-

cluster-adminクラスターロールを持つユーザーとして、またはopenshift-user-workload-monitoringプロジェクトのuser-workload-monitoring-config-editロールを持つユーザーとして、クラスターにアクセスできる。 -

user-workload-monitoring-configConfigMapオブジェクトを作成している。

-

手順

openshift-monitoringプロジェクトで Prometheus のクエリーログファイルを設定するには:openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yamlの下のprometheusK8sのqueryLogFile: <path>を追加します:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- クエリーがログに記録されるファイルへのフルパス。

変更を適用するためにファイルを保存します。

警告monitoring config map への変更を保存すると、関連プロジェクトの Pod およびその他のリソースが再デプロイされる場合があります。該当するプロジェクトの実行中のモニタリングプロセスも再起動する可能性があります。

コンポーネントの Pod が実行中であることを確認します。次のコマンドの例は、

openshift-monitoringプロジェクトの Pod のステータスを一覧表示します。oc -n openshift-monitoring get pods

$ oc -n openshift-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow クエリーログを読みます。

oc -n openshift-monitoring exec prometheus-k8s-0 -- cat <path>

$ oc -n openshift-monitoring exec prometheus-k8s-0 -- cat <path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要ログに記録されたクエリー情報を確認した後、config map の設定を元に戻します。

openshift-user-workload-monitoringプロジェクトで Prometheus のクエリーログファイルを設定するには:openshift-user-workload-monitoringプロジェクトでuser-workload-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yamlの下のprometheusのqueryLogFile: <path>を追加します:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- クエリーがログに記録されるファイルへのフルパス。

変更を適用するためにファイルを保存します。

注記user-workload-monitoring-configConfigMapオブジェクトに適用される設定は、クラスター管理者がユーザー定義プロジェクトのモニタリングを有効にしない限りアクティブにされません。警告monitoring config map への変更を保存すると、関連プロジェクトの Pod およびその他のリソースが再デプロイされる場合があります。該当するプロジェクトの実行中のモニタリングプロセスも再起動する可能性があります。

コンポーネントの Pod が実行中であることを確認します。以下の例は、

openshift-user-workload-monitoringプロジェクトの Pod のステータスを一覧表示します。oc -n openshift-user-workload-monitoring get pods

$ oc -n openshift-user-workload-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow クエリーログを読みます。

oc -n openshift-user-workload-monitoring exec prometheus-user-workload-0 -- cat <path>

$ oc -n openshift-user-workload-monitoring exec prometheus-user-workload-0 -- cat <path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要ログに記録されたクエリー情報を確認した後、config map の設定を元に戻します。

3.4. Thanos Querier のクエリーロギングの有効化

openshift-monitoring プロジェクトのデフォルトのプラットフォームモニタリングの場合、Cluster Monitoring Operator を有効にして Thanos Querier によって実行されるすべてのクエリーをログに記録できます。

ログローテーションはサポートされていないため、問題のトラブルシューティングが必要な場合にのみ、この機能を一時的に有効にします。トラブルシューティングが終了したら、ConfigMapオブジェクトに加えた変更を元に戻してクエリーログを無効にし、機能を有効にします。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。

手順

openshift-monitoring プロジェクトで Thanos Querier のクエリーロギングを有効にすることができます。

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例のように

thanosQuerierセクションをdata/config.yamlに追加し、値を追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 変更を適用するためにファイルを保存します。

警告monitoring config map への変更を保存すると、関連プロジェクトの Pod およびその他のリソースが再デプロイされる場合があります。該当するプロジェクトの実行中のモニタリングプロセスも再起動する可能性があります。

検証

Thanos Querier Pod が実行されていることを確認します。次のコマンドの例は、

openshift-monitoringプロジェクトの Pod のステータスを一覧表示します。oc -n openshift-monitoring get pods

$ oc -n openshift-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のサンプルコマンドをモデルとして使用して、テストクエリーを実行します。

token=`oc sa get-token prometheus-k8s -n openshift-monitoring` oc -n openshift-monitoring exec -c prometheus prometheus-k8s-0 -- curl -k -H "Authorization: Bearer $token" 'https://thanos-querier.openshift-monitoring.svc:9091/api/v1/query?query=cluster_version'

$ token=`oc sa get-token prometheus-k8s -n openshift-monitoring` $ oc -n openshift-monitoring exec -c prometheus prometheus-k8s-0 -- curl -k -H "Authorization: Bearer $token" 'https://thanos-querier.openshift-monitoring.svc:9091/api/v1/query?query=cluster_version'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行してクエリーログを読み取ります。

oc -n openshift-monitoring logs <thanos_querier_pod_name> -c thanos-query

$ oc -n openshift-monitoring logs <thanos_querier_pod_name> -c thanos-queryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記thanos-querierPod は高可用性 (HA) Pod であるため、1 つの Pod でのみログを表示できる可能性があります。-

ログに記録されたクエリー情報を確認したら、設定マップで

enableRequestLoggingの値をfalseに変更してクエリーロギングを無効にします。

第4章 Prometheus アダプターの監査ログレベルの設定

デフォルトのプラットフォームモニタリングでは、Prometheus アダプターの監査ログレベルを設定できます。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。

手順

デフォルトの openshift-monitoring プロジェクトで Prometheus アダプターの監査ログレベルを設定できます。

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow k8sPrometheusAdapter/auditセクションにprofile:をdata/config.yamlの下に追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Prometheus アダプターに適用する監査ログレベル。

profile:パラメーターに以下のいずれかの値を使用して、監査ログレベルを設定します。-

None: イベントをログに記録しません。 -

Metadata: ユーザー、タイムスタンプなど、リクエストのメタデータのみをログに記録します。リクエストテキストと応答テキストはログに記録しないでください。metadataはデフォルトの監査ログレベルです。 -

Request: メタデータと要求テキストのみをログに記録しますが、応答テキストはログに記録しません。このオプションは、リソース以外の要求には適用されません。 -

RequestResponse: イベントのメタデータ、要求テキスト、および応答テキストをログに記録します。このオプションは、リソース以外の要求には適用されません。

-

変更を適用するためにファイルを保存します。変更を適用すると、Prometheus Adapter 用の Pod が自動的に再起動します。

警告変更がモニタリング設定マップに保存されると、関連するプロジェクトの Pod およびその他のリソースが再デプロイされる可能性があります。該当するプロジェクトの実行中のモニタリングプロセスも再起動する可能性があります。

検証

-

設定マップの

k8sPrometheusAdapter/audit/profileで、ログレベルをRequestに設定し、ファイルを保存します。 Prometheus アダプターの Pod が実行されていることを確認します。以下の例は、

openshift-monitoringプロジェクトの Pod のステータスを一覧表示します。oc -n openshift-monitoring get pods

$ oc -n openshift-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 監査ログレベルと監査ログファイルのパスが正しく設定されていることを確認します。

oc -n openshift-monitoring get deploy prometheus-adapter -o yaml

$ oc -n openshift-monitoring get deploy prometheus-adapter -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

... - --audit-policy-file=/etc/audit/request-profile.yaml - --audit-log-path=/var/log/adapter/audit.log

... - --audit-policy-file=/etc/audit/request-profile.yaml - --audit-log-path=/var/log/adapter/audit.logCopy to Clipboard Copied! Toggle word wrap Toggle overflow 正しいログレベルが

openshift-monitoringプロジェクトのprometheus-adapterデプロイメントに適用されていることを確認します。oc -n openshift-monitoring exec deploy/prometheus-adapter -c prometheus-adapter -- cat /etc/audit/request-profile.yaml

$ oc -n openshift-monitoring exec deploy/prometheus-adapter -c prometheus-adapter -- cat /etc/audit/request-profile.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記ConfigMapオブジェクトで Prometheus アダプターに認識されないprofile値を入力すると、Prometheus アダプターには変更が加えられず、Cluster Monitoring Operator によってエラーがログに記録されます。Prometheus アダプターの監査ログを確認します。

oc -n openshift-monitoring exec -c <prometheus_adapter_pod_name> -- cat /var/log/adapter/audit.log

$ oc -n openshift-monitoring exec -c <prometheus_adapter_pod_name> -- cat /var/log/adapter/audit.logCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1. デフォルトの Grafana デプロイメントの無効化

デフォルトでは、読み取り専用の Grafana インスタンスは、クラスターメトリクスを表示するダッシュボードのコレクションと共にデプロイされます。Grafana インスタンスは、ユーザー側で設定できません。

Grafana デプロイメントを無効にすると、関連するリソースがクラスターから削除されます。これらのダッシュボードを必要とせずに、クラスターのリソースを節約するには、以下を行うことができます。ただし、引き続き Web コンソールに含まれるメトリクスおよびダッシュボードを表示できます。Grafana はいつでも再度有効化することができます。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。 -

OpenShift CLI (

oc) がインストールされている。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow grafanaコンポーネントのenabled: falseをdata/config.yamlの下に追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 変更を適用するためにファイルを保存します。リソースは、変更を適用したら、自動的に削除されます。

警告この変更により、Prometheus および Thanos Querier など、一部のコンポーネントが生成されます。これにより、永続ストレージの設定のセクションの手順が完了していない場合に、収集されたメトリクスが失われる可能性があります。

Grafana Pod が実行されていないことを確認します。以下の例は、

openshift-monitoringプロジェクトの Pod のステータスを一覧表示します。oc -n openshift-monitoring get pods

$ oc -n openshift-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記これらの Pod を終了するまでに数分かかる場合があります。

4.2. ローカル Alertmanager の無効化

Prometheus インスタンスからのアラートをルーティングするローカル Alertmanager は、OpenShift ContainerPlatform モニタリングスタックの openshift-monitoring プロジェクトではデフォルトで有効になっています。

ローカル Alertmanager を必要としない場合、openshift-monitoring プロジェクトで cluster-monitoring-config 設定マップを指定して無効にできます。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

cluster-monitoring-configConfigMap を作成している。 -

OpenShift CLI (

oc) がインストールされている。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMap を編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yamlの下に、alertmanagerMainコンポーネントのenabled: falseを追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を適用するためにファイルを保存します。Alertmanager インスタンスは、この変更を適用すると自動的に無効にされます。

4.3. 次のステップ

- ユーザー定義プロジェクトのモニタリングの有効化

- リモート正常性レポート を確認し、必要な場合はこれをオプトアウトします。

第5章 ユーザー定義プロジェクトのモニタリングの有効化

OpenShift Container Platform 4.10 では、デフォルトのプラットフォームのモニタリングに加えて、ユーザー定義プロジェクトのモニタリングを有効にできます。追加のモニタリングソリューションを必要とせずに、Open Shift Container Platform で独自のプロジェクトをモニタリングできます。この機能を使用することで、コアプラットフォームコンポーネントおよびユーザー定義プロジェクトのモニタリングが一元化されます。

Operator Lifecycle Manager (OLM) を使用してインストールされた Prometheus Operator のバージョンは、ユーザー定義のモニタリングと互換性がありません。そのため、OLM Prometheus Operator によって管理される Prometheus カスタムリソース (CR) としてインストールされるカスタム Prometheus インスタンスは OpenShift Container Platform ではサポートされていません。

5.1. ユーザー定義プロジェクトのモニタリングの有効化

クラスター管理者は、クラスターモニタリング ConfigMap オブジェクト に enableUserWorkload: true フィールドを設定し、ユーザー定義プロジェクトのモニタリングを有効にできます。

OpenShift Container Platform 4.10 では、ユーザー定義プロジェクトのモニタリングを有効にする前に、カスタム Prometheus インスタンスを削除する必要があります。

OpenShift Container Platform のユーザー定義プロジェクトのモニタリングを有効にするには、cluster-admin クラスターロールを持つユーザーとしてクラスターにアクセスできる必要があります。これにより、クラスター管理者は任意で、ユーザー定義のプロジェクトをモニターするコンポーネントを設定するパーミッションをユーザーに付与できます。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 -

OpenShift CLI (

oc) がインストールされている。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。 オプションで

user-workload-monitoring-configConfigMapをopenshift-user-workload-monitoringプロジェクトに作成している。ユーザー定義プロジェクトをモニターするコンポーネントのConfigMapに設定オプションを追加できます。注記設定の変更を

user-workload-monitoring-configConfigMapに保存するたびに、openshift-user-workload-monitoringプロジェクトの Pod が再デプロイされます。これらのコンポーネントが再デプロイするまで時間がかかる場合があります。ユーザー定義プロジェクトのモニタリングを最初に有効にする前にConfigMapオブジェクトを作成し、設定することができます。これにより、Pod を頻繁に再デプロイする必要がなくなります。

手順

cluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow enableUserWorkload: trueをdata/config.yamlの下に追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

trueに設定すると、enableUserWorkloadパラメーターはクラスター内のユーザー定義プロジェクトのモニタリングを有効にします。

変更を適用するためにファイルを保存します。ユーザー定義プロジェクトのモニタリングは自動的に有効になります。

警告変更が

cluster-monitoring-configConfigMapオブジェクトに保存されると、openshift-monitoringプロジェクトの Pod および他のリソースは再デプロイされる可能性があります。該当するプロジェクトの実行中のモニタリングプロセスも再起動する可能性があります。prometheus-operator、prometheus-user-workloadおよびthanos-ruler-user-workloadPod がopenshift-user-workload-monitoringプロジェクトで実行中であることを確認します。Pod が起動するまでに少し時間がかかる場合があります。oc -n openshift-user-workload-monitoring get pod

$ oc -n openshift-user-workload-monitoring get podCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2. ユーザーに対するユーザー定義のプロジェクトをモニターするパーミッションの付与

クラスター管理者は、すべての OpenShift Container Platform のコアプロジェクトおよびユーザー定義プロジェクトをモニターできます。

クラスター管理者は、開発者およびその他のユーザーに、独自のプロジェクトをモニターするパーミッションを付与できます。特権は、以下のモニタリングロールのいずれかを割り当てることで付与されます。

-

monitoring-rules-view クラスターロールは、プロジェクトの

PrometheusRuleカスタムリソースへの読み取りアクセスを提供します。 -

monitoring-rules-edit クラスターロールは、プロジェクトの

PrometheusRuleカスタムリソースを作成し、変更し、削除するパーミッションをユーザーに付与します。 -

monitoring-edit クラスターロールは、

monitoring-rules-editクラスターロールと同じ特権を付与します。さらに、ユーザーはサービスまたは Pod の新規の収集 ターゲットを作成できます。このロールを使用すると、ServiceMonitorおよびPodMonitorリソースを作成し、変更し、削除することもできます。

また、ユーザー定義のプロジェクトをモニターするコンポーネントを設定するパーミッションをユーザーに付与することもできます。

-

openshift-user-workload-monitoringプロジェクトの user-workload-monitoring-config-edit ロールにより、user-workload-monitoring-configConfigMapオブジェクトを編集できます。このロールを使用して、ConfigMapオブジェクトを編集し、ユーザー定義のワークロードモニタリング用に Prometheus、Prometheus Operator、および Thanos Ruler を設定できます。

また、ユーザー定義プロジェクトのアラートルーティングを設定するパーミッションをユーザーに付与することもできます。

-

alert-routing-edit クラスターロールは、プロジェクトの

AlertmanagerConfigカスタムリソースを作成、更新、および削除するパーミッションをユーザーに付与します。

このセクションでは、OpenShift Container Platform Web コンソールまたは CLI を使用してこれらのロールを割り当てる方法について説明します。

5.2.1. Web コンソールを使用したユーザーパーミッションの付与

OpenShift Container Platform Web コンソールを使用して、独自のプロジェクトをモニターするパーミッションをユーザーに付与できます。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 - ロールを割り当てるユーザーアカウントがすでに存在している。

手順

- OpenShift Container Platform Web コンソールの Administrator パースペクティブで、User Management → Role Bindings → Create Binding に移動します。

- Binding Typeで、Namespace Role Binding タイプを選択します。

- Name フィールドに、ロールバインディングの名前を入力します。

Namespace フィールドで、アクセスを付与するユーザー定義プロジェクトを選択します。

重要モニタリングロールは、Namespace フィールドで適用するプロジェクトにバインドされます。この手順を使用してユーザーに付与するパーミッションは、選択されたプロジェクトにのみ適用されます。

-

Role Name 一覧で、

monitoring-rules-view、monitoring-rules-edit、またはmonitoring-editを選択します。 - Subject セクションで、User を選択します。

- Subject Name フィールドにユーザーの名前を入力します。

- Create を選択して、ロールバインディングを適用します。

5.2.2. CLI を使用したユーザーパーミッションの付与

OpenShift CLI (oc) を使用して、独自のプロジェクトをモニターするパーミッションをユーザーに付与できます。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 - ロールを割り当てるユーザーアカウントがすでに存在している。

-

OpenShift CLI (

oc) がインストールされている。

手順

プロジェクトのユーザーにモニタリングロールを割り当てます。

oc policy add-role-to-user <role> <user> -n <namespace>

$ oc policy add-role-to-user <role> <user> -n <namespace>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<role>をmonitoring-rules-view、monitoring-rules-edit、またはmonitoring-editに置き換えます。

重要選択したすべてのロールは、クラスター管理者が特定のプロジェクトにバインドする必要があります。

たとえば、

<role>をmonitoring-editに、<user>をjohnsmithに、<namespace>をns1に置き換えます。これにより、ユーザーjohnsmithに、メトリクスコレクションをセットアップし、ns1namespace にアラートルールを作成するパーミッションが割り当てられます。

5.3. ユーザーに対するユーザー定義プロジェクトのモニタリングを設定するためのパーミッションの付与

ユーザーに対して、ユーザー定義プロジェクトのモニタリングを設定するためのパーミッションを付与できます。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 - ロールを割り当てるユーザーアカウントがすでに存在している。

-

OpenShift CLI (

oc) がインストールされている。

手順

user-workload-monitoring-config-editロールをopenshift-user-workload-monitoringプロジェクトのユーザーに割り当てます。oc -n openshift-user-workload-monitoring adm policy add-role-to-user \ user-workload-monitoring-config-edit <user> \ --role-namespace openshift-user-workload-monitoring

$ oc -n openshift-user-workload-monitoring adm policy add-role-to-user \ user-workload-monitoring-config-edit <user> \ --role-namespace openshift-user-workload-monitoringCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4. カスタムアプリケーションについてのクラスター外からのメトリクスへのアクセス

独自のサービスをモニタリングする際に、コマンドラインから Prometheus 統計をクエリーする方法を説明します。クラスター外からモニタリングデータにアクセスするには、thanos-querier ルートを使用します。

前提条件

- 独自のサービスをデプロイしている。ユーザー定義プロジェクトのモニタリングの有効化手順に従ってください。

手順

トークンを展開して Prometheus に接続します。

SECRET=`oc get secret -n openshift-user-workload-monitoring | grep prometheus-user-workload-token | head -n 1 | awk '{print $1 }'`$ SECRET=`oc get secret -n openshift-user-workload-monitoring | grep prometheus-user-workload-token | head -n 1 | awk '{print $1 }'`Copy to Clipboard Copied! Toggle word wrap Toggle overflow TOKEN=`echo $(oc get secret $SECRET -n openshift-user-workload-monitoring -o json | jq -r '.data.token') | base64 -d`

$ TOKEN=`echo $(oc get secret $SECRET -n openshift-user-workload-monitoring -o json | jq -r '.data.token') | base64 -d`Copy to Clipboard Copied! Toggle word wrap Toggle overflow ルートホストを展開します。

THANOS_QUERIER_HOST=`oc get route thanos-querier -n openshift-monitoring -o json | jq -r '.spec.host'`

$ THANOS_QUERIER_HOST=`oc get route thanos-querier -n openshift-monitoring -o json | jq -r '.spec.host'`Copy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドラインで独自のサービスのメトリクスをクエリーします。以下に例を示します。

NAMESPACE=ns1

$ NAMESPACE=ns1Copy to Clipboard Copied! Toggle word wrap Toggle overflow curl -X GET -kG "https://$THANOS_QUERIER_HOST/api/v1/query?" --data-urlencode "query=up{namespace='$NAMESPACE'}" -H "Authorization: Bearer $TOKEN"$ curl -X GET -kG "https://$THANOS_QUERIER_HOST/api/v1/query?" --data-urlencode "query=up{namespace='$NAMESPACE'}" -H "Authorization: Bearer $TOKEN"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力には、アプリケーション Pod が起動していた期間が表示されます。

出力例

{"status":"success","data":{"resultType":"vector","result":[{"metric":{"__name__":"up","endpoint":"web","instance":"10.129.0.46:8080","job":"prometheus-example-app","namespace":"ns1","pod":"prometheus-example-app-68d47c4fb6-jztp2","service":"prometheus-example-app"},"value":[1591881154.748,"1"]}]}}{"status":"success","data":{"resultType":"vector","result":[{"metric":{"__name__":"up","endpoint":"web","instance":"10.129.0.46:8080","job":"prometheus-example-app","namespace":"ns1","pod":"prometheus-example-app-68d47c4fb6-jztp2","service":"prometheus-example-app"},"value":[1591881154.748,"1"]}]}}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.5. モニタリングからのユーザー定義のプロジェクトを除く

ユーザー定義のプロジェクトは、ユーザーワークロード監視から除外できます。これを実行するには、単に openshift.io/user-monitoring ラベルに false を指定して、プロジェクトの namespace に追加します。

手順

ラベルをプロジェクト namespace に追加します。

oc label namespace my-project 'openshift.io/user-monitoring=false'

$ oc label namespace my-project 'openshift.io/user-monitoring=false'Copy to Clipboard Copied! Toggle word wrap Toggle overflow モニタリングを再度有効にするには、namespace からラベルを削除します。

oc label namespace my-project 'openshift.io/user-monitoring-'

$ oc label namespace my-project 'openshift.io/user-monitoring-'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記プロジェクトにアクティブな監視ターゲットがあった場合、ラベルを追加した後、Prometheus がそれらのスクレイピングを停止するまでに数分かかる場合があります。

5.6. ユーザー定義プロジェクトのモニタリングの無効化

ユーザー定義プロジェクトのモニタリングを有効にした後に、クラスターモニタリング ConfigMap オブジェクトに enableUserWorkload: false を設定してこれを再度無効にできます。

または、enableUserWorkload: true を削除して、ユーザー定義プロジェクトのモニタリングを無効にできます。

手順

cluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yamlでenableUserWorkload:をfalseに設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- 変更を適用するためにファイルを保存します。ユーザー定義プロジェクトのモニタリングは自動的に無効になります。

prometheus-operator、prometheus-user-workloadおよびthanos-ruler-user-workloadPod がopenshift-user-workload-monitoringプロジェクトで終了していることを確認します。これには少し時間がかかる場合があります。oc -n openshift-user-workload-monitoring get pod

$ oc -n openshift-user-workload-monitoring get podCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

No resources found in openshift-user-workload-monitoring project.

No resources found in openshift-user-workload-monitoring project.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

openshift-user-workload-monitoring プロジェクトの user-workload-monitoring-config ConfigMap オブジェクトは、ユーザー定義プロジェクトのモニタリングが無効にされている場合は自動的に削除されません。これにより、ConfigMap で作成した可能性のあるカスタム設定を保持されます。

5.7. 次のステップ

第6章 ユーザー定義プロジェクトのアラートルーティングの有効化

ユーザー定義プロジェクトのアラートルーティングは、テクノロジープレビュー機能としてのみご利用いただけます。テクノロジープレビュー機能は Red Hat の実稼働環境でのサービスレベルアグリーメント (SLA) ではサポートされていないため、Red Hat では実稼働環境での使用を推奨していません。Red Hat は実稼働環境でこれらを使用することを推奨していません。テクノロジープレビュー機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

OpenShift Container Platform 4.10 では、クラスター管理者がユーザー定義プロジェクトのアラートルーティングを有効にできます。

6.1. ユーザー定義プロジェクトのアラートルーティングについて

クラスター管理者は、ユーザー定義プロジェクトのアラートルーティングを有効にできます。有効にした後、ユーザーが、ユーザー定義プロジェクトのアラートルーティングを設定できるようにすることができます。次に、ユーザーは AlertmanagerConfig オブジェクトを作成または編集して、ユーザー定義のアラートルーティングを作成し、設定できます。

ユーザーが、ユーザー定義プロジェクトのアラートルーティングを定義した後、ユーザー定義のアラートは openshift-monitoring namespace の alertmanager-main Pod にルーティングされます。

ユーザー定義プロジェクトのアラートルーティングに関する以下の制限および機能に注意してください。

-

ユーザー定義のアラートルールの場合、ユーザー定義のルーティングはリソースが定義される namespace に対してスコープ指定されます。たとえば、namespace

ns1のルーティング設定は、同じ namespace のPrometheusRulesリソースにのみ適用されます。 - Cluster Monitoring Operator(CMO) は、ユーザー定義のアラート専用の 2 つ目の Alertmanager サービスをデプロイしません。クラスター管理者は、カスタムシークレットまたは OpenShift Container Platform Web コンソールを使用して、引き続きメインの Alertmanager 設定を定義します。

-

namespace がユーザー定義のモニタリングから除外される場合、namespace の

AlertmanagerConfigリソースは、Alertmanager 設定の一部ではなくなります。

6.2. ユーザー定義プロジェクトのアラートルーティングの有効化

ユーザー定義プロジェクトのアラートルーティングを有効にできます。これを実行することで、alert-routing-edit ロールを持つユーザーが、Alertmanager でユーザー定義プロジェクトのアラートルーティングおよびレシーバーを設定できるようにします。

前提条件

- ユーザー定義プロジェクトのモニタリングを有効にしている。

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 -

OpenShift CLI (

oc) がインストールされている。

手順

cluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow enableUserAlertmanagerConfig: trueをdata/config.yamlのalertmanagerMainキーの下に追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

trueに設定すると、enableUserAlertmanagerConfigパラメーターはクラスター内のユーザー定義プロジェクトのアラートルーティングを有効にします。

- 変更を適用するためにファイルを保存します。ユーザー定義プロジェクトのアラートルーティングは自動的に有効にされます。

6.3. ユーザー定義プロジェクトのアラートルーティングを設定するためのユーザーへのパーミッションの付与

ユーザー定義プロジェクトのアラートルーティングを設定するパーミッションをユーザーに付与できます。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできます。 - ロールを割り当てるユーザーアカウントがすでに存在している。

-

OpenShift CLI (

oc) がインストールされている。 - ユーザー定義プロジェクトのモニタリングを有効にしている。

手順

ユーザー定義プロジェクトのユーザーに

alert-routing-editクラスターロールを割り当てます。oc -n <namespace> adm policy add-role-to-user alert-routing-edit <user>

$ oc -n <namespace> adm policy add-role-to-user alert-routing-edit <user>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<namespace>の場合は、ユーザー定義プロジェクトの代わりに namespace を使用します (例:ns1)。<user>の場合は、ロールを割り当てるアカウントの代わりにユーザー名を使用します。

6.4. ユーザー定義プロジェクトのアラートルーティングの無効化

ユーザー定義プロジェクトのアラートルーティングを有効にしている場合は、これを無効にすることができます。これを実行することで、alert-routing-edit ロールを持つユーザーが Alertmanager でユーザー定義プロジェクトのアラートルーティングを設定できないようにします。

ユーザー定義プロジェクトのアラートルーティングはデフォルトで無効になっています。この機能がまだ有効になっていない場合は、無効にする必要はありません。

前提条件

- ユーザー定義プロジェクトのモニタリングを有効にしている。

- ユーザー定義プロジェクトのアラートルーティングを有効にしている。

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 -

OpenShift CLI (

oc) がインストールされている。

手順

cluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yamlのalertmanagerMainキー配下でenableUserAlertmanagerConfigの値をfalseに変更します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

falseに設定されている場合、enableUserAlertmanagerConfigパラメーターは、クラスター内のユーザー定義プロジェクトのアラートルーティングを無効にします。

- 変更を適用するためにファイルを保存します。ユーザー定義プロジェクトのアラートルーティングは自動的に無効になります。

6.5. 次のステップ

第7章 メトリックの管理

メトリクスを使用すると、クラスターコンポーネントおよび独自のワークロードのパフォーマンスをモニターできます。

7.1. メトリクスについて

OpenShift Container Platform 4.10 では、クラスターコンポーネントは、サービスエンドポイントを介して公開されたメトリクスをスクレイピングすることでモニターされます。ユーザー定義プロジェクトのメトリクスのコレクションを設定することもできます。

Prometheus クライアントライブラリーをアプリケーションレベルで使用することで、独自のワークロードに指定するメトリクスを定義できます。