This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.Service Mesh

Service Mesh のインストール、使用法、およびリリースノート

概要

第1章 Service Mesh 2.x

1.1. OpenShift Service Mesh について

Red Hat OpenShift Service Mesh は OpenShift Container Platform とは異なる頻度でリリースされ、Red Hat OpenShift Service Mesh Operator は ServiceMeshControlPlane の複数のバージョンのデプロイをサポートしているため、Service Mesh のドキュメントでは、本製品のマイナーバージョン用に個別のドキュメントセットを維持していません。現在のドキュメントセットは、特定のトピックまたは特定の機能でバージョン固有の制限がない限り、現在サポートされている Service Mesh の最新バージョンに適用されます。

Red Hat OpenShift Service Mesh のライフサイクルとサポートされるプラットフォームに関する追加情報は、プラットフォームライフサイクルポリシー を参照してください。

1.1.1. Red Hat OpenShift Service Mesh の概要

Red Hat OpenShift Service Mesh は、アプリケーションで一元化された制御ポイントを作成して、マイクロサービスアーキテクチャーのさまざまな問題に対応します。OpenShift Service Mesh はアプリケーションコードを変更せずに、既存の分散アプリケーションに透過的な層を追加します。

マイクロサービスアーキテクチャーは、エンタープライズアプリケーションの作業をモジュールサービスに分割するため、スケーリングとメンテナンスが容易になります。ただし、マイクロサービスアーキテクチャー上に構築されるエンタープライズアプリケーションはサイズも複雑性も増すため、マイクロサービスアーキテクチャーの理解と管理は困難です。Service Mesh は、サービス間のトラフィックをキャプチャーしたり、インターセプトしたりして、他のサービスへの新規要求を変更、リダイレクト、または作成することによってこれらのアーキテクチャーの問題に対応できます。

オープンソースの Istio プロジェクト をベースにする Service Mesh では、検出、負荷分散、サービス間の認証、障害復旧、メトリクス、およびモニタリングを提供する、デプロイされたサービスのネットワークを簡単に作成できます。サービスメッシュは、A/B テスト、カナリアリリース、レート制限、アクセス制御、エンドツーエンド認証を含む、より複雑な運用機能を提供します。

1.1.2. コア機能

Red Hat OpenShift Service Mesh は、サービスのネットワーク全体で多数の主要機能を均一に提供します。

- トラフィック管理: サービス間でトラフィックおよび API 呼び出しのフローを制御し、呼び出しの安定度を高め、不利な条件下でもネットワークの堅牢性を維持します。

- サービス ID とセキュリティー: メッシュのサービスを検証可能な ID で指定でき、サービスのトラフィックがさまざまな信頼度のネットワークに送られる際にそのトラフィックを保護する機能を提供します。

- ポリシーの適用: サービス間の対話に組織のポリシーを適用し、アクセスポリシーが適用され、リソースはコンシューマー間で均等に分散されるようにします。ポリシー変更は、アプリケーションコードを変更するのではなく、メッシュを設定して行います。

- テレメトリー: サービス間の依存関係やそれらの間のトラフィックの性質やフローを理解するのに役立ち、問題を素早く特定できます。

1.2. Service Mesh リリースノート

1.2.1. 多様性を受け入れるオープンソースの強化

Red Hat では、コード、ドキュメント、Web プロパティーにおける配慮に欠ける用語の置き換えに取り組んでいます。まずは、マスター (master)、スレーブ (slave)、ブラックリスト (blacklist)、ホワイトリスト (whitelist) の 4 つの用語の置き換えから始めます。この取り組みは膨大な作業を要するため、今後の複数のリリースで段階的に用語の置き換えを実施して参ります。詳細は、Red Hat CTO である Chris Wright のメッセージ をご覧ください。

1.2.2. 新機能および拡張機能

今回のリリースでは、以下のコンポーネントおよび概念に関連する拡張機能が追加されました。

1.2.2.1. Red Hat OpenShift Service Mesh バージョン 2.4.2 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.10 以降でサポートされます。

1.2.2.1.1. Red Hat OpenShift Service Mesh バージョン 2.4.2 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.16.7 |

| Envoy プロキシー | 1.24.10 |

| Jaeger | 1.42.0 |

| Kiali | 1.65.7 |

1.2.2.2. Red Hat OpenShift Service Mesh バージョン 2.4.1 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.10 以降でサポートされます。

1.2.2.2.1. Red Hat OpenShift Service Mesh バージョン 2.4.1 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.16.5 |

| Envoy プロキシー | 1.24.8 |

| Jaeger | 1.42.0 |

| Kiali | 1.65.7 |

1.2.2.3. Red Hat OpenShift Service Mesh バージョン 2.4 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.10 以降でサポートされます。

1.2.2.3.1. Red Hat OpenShift Service Mesh バージョン 2.4 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.16.5 |

| Envoy プロキシー | 1.24.8 |

| Jaeger | 1.42.0 |

| Kiali | 1.65.6 |

1.2.2.3.2. クラスター全体のデプロイメント

この機能拡張により、クラスター全体のデプロイメントの一般利用可能なバージョンが導入されます。クラスター全体のデプロイメントには、クラスター全体のリソースを監視する Service Mesh Control Plane が含まれます。コントロールプレーンは、すべての namespace で単一のクエリーを使用して、メッシュ設定に影響を与える各 Istio または Kubernetes リソースの種類を監視します。クラスター全体のデプロイメントでコントロールプレーンが実行するクエリーの数を減らすと、パフォーマンスが向上します。

1.2.2.3.3. ディスカバリーセレクターのサポート

この機能強化により、meshConfig.discoverySelectors フィールドの一般利用可能なバージョンが導入され、これをクラスター全体のデプロイメントで使用して、サービスメッシュコントロールプレーンが検出できるサービスを制限できます。

1.2.2.3.4. cert-manager istio-csr との統合

この更新により、Red Hat OpenShift Service Mesh は cert-manager コントローラーおよび istio-csr エージェントと統合されます。cert-manager は、証明書と証明書発行者を Kubernetes クラスター内のリソースタイプとして追加し、それらの証明書の取得、更新、使用のプロセスを簡素化します。cert-manager は、Istio の中間 CA 証明書を提供し、ローテーションします。istio-csr との統合により、ユーザーは Istio プロキシーからの署名証明書要求を cert-manager に委任できます。ServiceMeshControlPlane v2.4 は cert-manager によって提供された CA 証明書を cacerts シークレットとして受け入れます。

cert-manager および istio-csr との統合は、IBM Power、IBM Z、および {linuxoneProductName} ではサポートされていません。

1.2.2.3.5. 外部認証システムとの統合

この機能強化により、AuthorizationPolicy リソースの action:CUSTOM フィールドを使用して、Red Hat OpenShift Service Mesh を外部認可システムと統合する一般に利用可能な方法が導入されました。envoyExtAuthzHttp フィールドを使用して、アクセス制御を外部認証システムに委任します。

1.2.2.3.6. 外部 Prometheus インストールとの統合

この機能拡張により、Prometheus 拡張プロバイダーの一般利用可能なバージョンが導入されます。spec.meshConfig 仕様で extensionProviders フィールドの値を prometheus に設定することで、OpenShift Container Platform モニタリングスタックまたはカスタム Prometheus インストールにメトリックを公開できます。テレメトリーオブジェクトは、トラフィックメトリックを収集するように Istio プロキシーを設定します。Service Mesh は、Prometheus メトリックの Telemetry API のみをサポートします。

1.2.2.3.7. シングルスタック IPv6 のサポート

この機能拡張により、シングルスタック IPv6 クラスターの一般利用可能なサポートが導入され、より広範囲の IP アドレスへのアクセスが提供されます。デュアルスタック IPv4 または IPv6 クラスターはサポートされていません。

シングルスタック IPv6 サポートは、IBM Power、IBM Z、および {linuxoneProductName} では利用できません。

1.2.2.3.8. OpenShift Container Platform Gateway API のサポート

OpenShift Container Platform Gateway API のサポートはテクノロジープレビュー機能としてのみご利用いただけます。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は実稼働環境でこれらを使用することを推奨していません。テクノロジープレビュー機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

この機能強化により、OpenShift Container Platform Gateway API の更新されたテクノロジープレビューバージョンが導入されます。デフォルトでは、OpenShift Container Platform Gateway API は無効になっています。

1.2.2.3.8.1. OpenShift Container Platform Gateway API の有効化

OpenShift Container Platform Gateway API を有効にするには、ServiceMeshControlPlane リソースの techPreview.gatewayAPI 仕様で、enabled フィールドの値を true に設定します。

spec:

techPreview:

gatewayAPI:

enabled: true

spec:

techPreview:

gatewayAPI:

enabled: true以前は、ゲートウェイ API を有効にするために環境変数が使用されていました。

1.2.2.3.9. インフラストラクチャーノードへのコントロールプレーンのデプロイメント

Service Mesh コントロールプレーンのデプロイメントが OpenShift インフラストラクチャーノードでサポートされ、文書化されるようになりました。詳細は、以下のドキュメントを参照してください。

- すべての Service Mesh コントロールプレーンコンポーネントをインフラストラクチャーノード上で実行するための設定

- 個別の Service Mesh コントロールプレーンコンポーネントをインフラストラクチャーノード上で実行するための設定

1.2.2.3.10. Istio 1.16 サポート

Service Mesh 2.4 は Istio 1.16 に基づいており、新機能と製品の機能強化をもたらします。多くの Istio 1.16 機能がサポートされていますが、次の例外に注意する必要があります。

- サイドカーの HBONE プロトコルは実験的な機能であり、サポートされていません。

- ARM64 アーキテクチャー上のサービスメッシュはサポートされていません。

- OpenTelemetry API は引き続きテクノロジープレビュー機能です。

1.2.2.4. Red Hat OpenShift Service Mesh バージョン 2.3.6 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.10 以降でサポートされます。

1.2.2.4.1. Red Hat OpenShift Service Mesh バージョン 2.3.6 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.14.5 |

| Envoy プロキシー | 1.22.11 |

| Jaeger | 1.42.0 |

| Kiali | 1.57.10 |

1.2.2.5. Red Hat OpenShift Service Mesh バージョン 2.3.5 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.10 以降でサポートされます。

1.2.2.5.1. Red Hat OpenShift Service Mesh バージョン 2.3.5 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.14.5 |

| Envoy プロキシー | 1.22.9 |

| Jaeger | 1.42.0 |

| Kiali | 1.57.10 |

1.2.2.6. Red Hat OpenShift Service Mesh バージョン 2.3.4 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.10 以降でサポートされます。

1.2.2.6.1. Red Hat OpenShift Service Mesh バージョン 2.3.4 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.14.6 |

| Envoy プロキシー | 1.22.9 |

| Jaeger | 1.42.0 |

| Kiali | 1.57.9 |

1.2.2.7. Red Hat OpenShift Service Mesh バージョン 2.3.3 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.9 以降でサポートされます。

1.2.2.7.1. Red Hat OpenShift Service Mesh バージョン 2.3.3 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.14.5 |

| Envoy プロキシー | 1.22.9 |

| Jaeger | 1.42.0 |

| Kiali | 1.57.7 |

1.2.2.8. Red Hat OpenShift Service Mesh バージョン 2.3.2 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.9 以降でサポートされます。

1.2.2.8.1. Red Hat OpenShift Service Mesh バージョン 2.3.2 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.14.5 |

| Envoy プロキシー | 1.22.7 |

| Jaeger | 1.39 |

| Kiali | 1.57.6 |

1.2.2.9. Red Hat OpenShift Service Mesh バージョン 2.3.1 の新機能

Red Hat OpenShift Service Mesh の本リリースには、新機能の導入、CVE (Common Vulnerabilities and Exposures) への対応、バグ修正が含まれ、OpenShift Container Platform 4.9 以降でサポートされます。

1.2.2.9.1. Red Hat OpenShift Service Mesh バージョン 2.3.1 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.14.5 |

| Envoy プロキシー | 1.22.4 |

| Jaeger | 1.39 |

| Kiali | 1.57.5 |

1.2.2.10. Red Hat OpenShift Service Mesh バージョン 2.3 の新機能

Red Hat OpenShift Service Mesh の本リリースには、新機能の導入、CVE (Common Vulnerabilities and Exposures) への対応、バグ修正が含まれ、OpenShift Container Platform 4.9 以降でサポートされます。

1.2.2.10.1. Red Hat OpenShift Service Mesh バージョン 2.3 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.14.3 |

| Envoy プロキシー | 1.22.4 |

| Jaeger | 1.38 |

| Kiali | 1.57.3 |

1.2.2.10.2. 新しい Container Network Interface (CNI) DaemonSet コンテナーと ConfigMap

openshift-operators namespace には、新しい istio CNI DaemonSet istio-cni-node-v2-3、新しい ConfigMap リソース、istio-cni-config-v2-3 が含まれています。

Service Mesh Control Plane 2.3 にアップグレードすると、既存の istio-cni-node DaemonSet は変更されず、新しい istio-cni-node-v2-3 DaemonSet が作成されます。

この名称変更は、以前のリリースや、以前のリリースを使用してデプロイされた Service Mesh Control Plane に関連付けられた istio-cni-node CNI DaemonSet には影響しません。

1.2.2.10.3. ゲートウェイ挿入のサポート

このリリースでは、ゲートウェイ挿入の一般利用可能なサポートが導入されています。ゲートウェイ設定は、サービスワークロードとともに実行するサイドカー Envoy プロキシーではなく、メッシュのエッジで実行するスタンドアロン Envoy プロキシーに適用されます。これにより、ゲートウェイオプションのカスタマイズ機能が有効になります。ゲートウェイ挿入を使用する場合は、ゲートウェイプロキシーを実行する namespace にリソース (Service、Deployment、Role、および RoleBinding) を作成する必要があります。

1.2.2.10.4. Istio 1.14 サポート

Service Mesh 2.3 は Istio 1.14 に基づいており、新機能と製品の機能強化をもたらします。多くの Istio 1.14 機能がサポートされていますが、次の例外に注意する必要があります。

- ProxyConfig API はサポートされていますが、image フィールドは例外です。

- Telemetry API はテクノロジープレビュー機能です。

- SPIRE ランタイムはサポートされていない機能です。

1.2.2.10.5. OpenShift Service Mesh Console

OpenShift Service Mesh コンソールはテクノロジープレビュー機能のみです。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は実稼働環境でこれらを使用することを推奨していません。テクノロジープレビュー機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

このリリースでは、Kiali インターフェイスを OpenShift Web コンソールに直接統合する OpenShift Container Platform Service Mesh Console のテクノロジープレビューバージョンが導入されています。追加情報は、OpenShift Service Mesh コンソールの紹介 (テクノロジープレビュー) を参照してください。

1.2.2.10.6. クラスター全体のデプロイメント

クラスター全体のデプロイメントは、テクノロジープレビュー機能のみです。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は実稼働環境でこれらを使用することを推奨していません。テクノロジープレビュー機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

このリリースでは、テクノロジープレビュー機能としてクラスター全体のデプロイメントが導入されています。クラスター全体のデプロイメントには、クラスター全体のリソースを監視する Service Mesh Control Plane が含まれます。コントロールプレーンは、すべての namespace で単一のクエリーを使用して、メッシュ設定に影響を与える各 Istio または Kubernetes リソースの種類を監視します。対照的に、マルチテナントアプローチでは、リソースの各種類で namespace ごとにクエリーを使用します。クラスター全体のデプロイメントでコントロールプレーンが実行するクエリーの数を減らすと、パフォーマンスが向上します。

このクラスター全体のデプロイメントドキュメントは、SMCP v2.3 を使用してデプロイメントされたコントロールプレーンにのみ適用されます。SMCP v2.3 を使用して作成されたクラスター全体のデプロイメントは、SMCP v2.4 を使用して作成されたクラスター全体のデプロイメントと互換性がありません。

1.2.2.10.6.1. クラスター全体のデプロイメントの設定

次の ServiceMeshControlPlane オブジェクトの例では、クラスター全体のデプロイを設定します。

クラスター全体のデプロイメント用に SMCP を作成する場合、ユーザーは cluster-admin ClusterRole に属している必要があります。SMCP がクラスター全体のデプロイメント用に設定されている場合は、それがクラスター内の唯一の SMCP である必要があります。コントロールプレーンモードをマルチテナントからクラスター全体 (またはクラスター全体からマルチテナント) に変更することはできません。マルチテナントコントロールプレーンがすでに存在する場合は、それを削除して、新しいコントロールプレーンを作成します。

この例では、クラスター全体のデプロイメント用に SMCP を設定します。

- 1

- Istiod が、個々の namespace を監視するのではなく、クラスターレベルでリソースを監視できるようにします。

さらに、SMMR もクラスター全体のデプロイメント用に設定する必要があります。この例では、クラスター全体のデプロイメント用に SMMR を設定します。

- 1

- 後で作成する namespace を含め、すべての namespace をメッシュに追加します。kube、openshift、kube-*、および openshift-* の namespace は、メッシュの一部ではありません。

1.2.2.11. Red Hat OpenShift Service Mesh バージョン 2.2.9 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.10 以降でサポートされます。

1.2.2.11.1. Red Hat OpenShift Service Mesh バージョン 2.2.9 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.12.9 |

| Envoy プロキシー | 1.20.8 |

| Jaeger | 1.42.0 |

| Kiali | 1.48.7 |

1.2.2.12. Red Hat OpenShift Service Mesh バージョン 2.2.8 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.10 以降でサポートされます。

1.2.2.12.1. Red Hat OpenShift Service Mesh バージョン 2.2.8 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.12.9 |

| Envoy プロキシー | 1.20.8 |

| Jaeger | 1.42.0 |

| Kiali | 1.48.7 |

1.2.2.13. Red Hat OpenShift Service Mesh バージョン 2.2.7 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.10 以降でサポートされます。

1.2.2.13.1. Red Hat OpenShift Service Mesh バージョン 2.2.7 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.12.9 |

| Envoy プロキシー | 1.20.8 |

| Jaeger | 1.42.0 |

| Kiali | 1.48.6 |

1.2.2.14. Red Hat OpenShift Service Mesh バージョン 2.2.6 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.9 以降でサポートされます。

1.2.2.14.1. Red Hat OpenShift Service Mesh バージョン 2.2.6 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.12.9 |

| Envoy プロキシー | 1.20.8 |

| Jaeger | 1.39 |

| Kiali | 1.48.5 |

1.2.2.15. Red Hat OpenShift Service Mesh バージョン 2.2.5 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.9 以降でサポートされます。

1.2.2.15.1. Red Hat OpenShift Service Mesh バージョン 2.2.5 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.12.9 |

| Envoy プロキシー | 1.20.8 |

| Jaeger | 1.39 |

| Kiali | 1.48.3 |

1.2.2.16. Red Hat OpenShift Service Mesh バージョン 2.2.4 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.9 以降でサポートされます。

1.2.2.16.1. Red Hat OpenShift Service Mesh バージョン 2.2.4 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.12.9 |

| Envoy プロキシー | 1.20.8 |

| Jaeger | 1.36.14 |

| Kiali | 1.48.3 |

1.2.2.17. Red Hat OpenShift Service Mesh バージョン 2.2.3 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.9 以降でサポートされます。

1.2.2.17.1. Red Hat OpenShift Service Mesh バージョン 2.2.3 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.12.9 |

| Envoy プロキシー | 1.20.8 |

| Jaeger | 1.36 |

| Kiali | 1.48.3 |

1.2.2.18. Red Hat OpenShift Service Mesh バージョン 2.2.2 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.9 以降でサポートされます。

1.2.2.18.1. Red Hat OpenShift Service Mesh バージョン 2.2.2 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.12.7 |

| Envoy プロキシー | 1.20.6 |

| Jaeger | 1.36 |

| Kiali | 1.48.2-1 |

1.2.2.18.2. ルートラベルのコピー

この機能強化により、アノテーションのコピーに加えて、OpenShift ルートの特定のラベルをコピーできます。Red Hat OpenShift Service Mesh は、Istio Gateway リソースに存在するすべてのラベルとアノテーション (kubectl.kubernetes.io で始まるアノテーションを除く) を管理対象の OpenShift Route リソースにコピーします。

1.2.2.19. Red Hat OpenShift Service Mesh バージョン 2.2.1 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.9 以降でサポートされます。

1.2.2.19.1. Red Hat OpenShift Service Mesh バージョン 2.2.1 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.12.7 |

| Envoy プロキシー | 1.20.6 |

| Jaeger | 1.34.1 |

| Kiali | 1.48.2-1 |

1.2.2.20. Red Hat OpenShift Service Mesh 2.2 の新機能

このリリースの Red Hat Service Mesh は、新しい機能と拡張機能を追加し、OpenShift Container Platform 4.9 以降でサポートされています。

1.2.2.20.1. Red Hat OpenShift Service Mesh バージョン 2.2 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.12.7 |

| Envoy プロキシー | 1.20.4 |

| Jaeger | 1.34.1 |

| Kiali | 1.48.0.16 |

1.2.2.20.2. WasmPlugin API

このリリースでは、WasmPlugin API のサポートが追加され、ServiceMeshExtension が非推奨になりました。

1.2.2.20.3. ROSA サポート

このリリースでは、マルチクラスターフェデレーションを含む Red Hat OpenShift on AWS (ROSA) のサービスメッシュサポートが導入されています。

1.2.2.20.4. istio-node DaemonSet の名前変更

このリリースでは、istio-node DaemonSet の名前が istio-cni-node に変更になり、アップストリーム Istio の名前と同じになりました。

1.2.2.20.5. エンボイサイドカーネットワークの変更

Istio 1.10 は、デフォルトで lo ではなく eth0 を使用してトラフィックをアプリケーションコンテナーに送信するように Envoy を更新しました。

1.2.2.20.6. Service Mesh コントロールプレーン 1.1

このリリースは、すべてのプラットフォームでの Service Mesh 1.1 に基づく Service Mesh コントロールプレーンのサポートの終了を示します。

1.2.2.20.7. Istio 1.12 サポート

Service Mesh 2.2 は Istio 1.12 に基づいており、新機能と製品の機能強化をもたらします。多くの Istio 1.12 機能がサポートされていますが、サポートされていない次の機能に注意する必要があります。

- AuthPolicy ドライランはテクノロジープレビュー機能です。

- gRPC Proxyless Service Mesh は、テクノロジープレビュー機能です。

- Telemetry API は、テクノロジープレビュー機能です。

- ディスカバリーセレクターはサポート対象外の機能です。

- 外部コントロールプレーンはサポート対象外の機能です。

- ゲートウェイインジェクションはサポート対象外の機能です。

1.2.2.20.8. Kubernetes Gateway API

Kubernetes Gateway API はテクノロジープレビュー機能です。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は実稼働環境でこれらを使用することを推奨していません。テクノロジープレビュー機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

Kubernetes Gateway API は、デフォルトで無効になっているテクノロジープレビュー機能です。Kubernetes API デプロイメントコントローラーが無効になっている場合は、ingress ゲートウェイを手動でデプロイし、作成されたゲートウェイオブジェクトにリンクする必要があります。

Kubernetes API デプロイコントローラーが有効になっている場合は、ゲートウェイオブジェクトが作成されると、ingress ゲートウェイが自動的にデプロイされます。

1.2.2.20.8.1. Gateway API CRD のインストール

Gateway API CRD は、デフォルトでは OpenShift クラスターにプリインストールされていません。SMCP で Gateway API サポートを有効にする前に、CRD をインストールします。

kubectl get crd gateways.gateway.networking.k8s.io || { kubectl kustomize "github.com/kubernetes-sigs/gateway-api/config/crd?ref=v0.4.0" | kubectl apply -f -; }

$ kubectl get crd gateways.gateway.networking.k8s.io || { kubectl kustomize "github.com/kubernetes-sigs/gateway-api/config/crd?ref=v0.4.0" | kubectl apply -f -; }1.2.2.20.8.2. Kubernetes Gateway API の有効化

この機能を有効にするには、ServiceMeshControlPlane で Istiod コンテナーに次の環境変数を設定します。

ゲートウェイ API リスナーでのルート接続を制限するには、SameNamespace または All 設定を使用します。Istio は、listeners.allowedRoutes.namespaces のラベルセレクターの使用を無視し、デフォルトの動作 (SameNamespace) に戻します。

1.2.2.20.8.3. 手動によるゲートウェイリソースへの既存ゲートウェイのリンク

Kubernetes API デプロイメントコントローラーが無効になっている場合は、ingress ゲートウェイを手動でデプロイし、作成されたゲートウェイリソースにリンクする必要があります。

1.2.2.21. Red Hat OpenShift Service Mesh 2.1.6 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.9 以降でサポートされます。

1.2.2.21.1. Red Hat OpenShift Service Mesh バージョン 2.1.6 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.9.9 |

| Envoy プロキシー | 1.17.5 |

| Jaeger | 1.36 |

| Kiali | 1.36.16 |

1.2.2.22. Red Hat OpenShift Service Mesh 2.1.5.2 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.9 以降でサポートされます。

1.2.2.22.1. Red Hat OpenShift Service Mesh バージョン 2.1.5.2 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.9.9 |

| Envoy プロキシー | 1.17.5 |

| Jaeger | 1.36 |

| Kiali | 1.24.17 |

1.2.2.23. Red Hat OpenShift Service Mesh 2.1.5.1 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.9 以降でサポートされます。

1.2.2.23.1. Red Hat OpenShift Service Mesh バージョン 2.1.5.1 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.9.9 |

| Envoy プロキシー | 1.17.5 |

| Jaeger | 1.36 |

| Kiali | 1.36.13 |

1.2.2.24. Red Hat OpenShift Service Mesh 2.1.5 の新機能

Red Hat OpenShift Service Mesh の本リリースには、CVE (Common Vulnerabilities and Exposures) への対応とバグ修正が含まれ、OpenShift Container Platform 4.9 以降でサポートされます。

1.2.2.24.1. Red Hat OpenShift Service Mesh バージョン 2.1.5 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.9.9 |

| Envoy プロキシー | 1.17.1 |

| Jaeger | 1.36 |

| Kiali | 1.36.12-1 |

1.2.2.25. Red Hat OpenShift Service Mesh 2.1.4 の新機能

このリリースの Red Hat OpenShift Service Mesh では、CVE (Common Vulnerabilities and Exposures) およびバグ修正に対応しています。

1.2.2.25.1. Red Hat OpenShift Service Mesh バージョン 2.1.4 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.9.9 |

| Envoy プロキシー | 1.17.1 |

| Jaeger | 1.30.2 |

| Kiali | 1.36.12-1 |

1.2.2.26. Red Hat OpenShift Service Mesh 2.1.3 の新機能

このリリースの Red Hat OpenShift Service Mesh では、CVE (Common Vulnerabilities and Exposures) およびバグ修正に対応しています。

1.2.2.26.1. Red Hat OpenShift Service Mesh バージョン 2.1.3 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.9.9 |

| Envoy プロキシー | 1.17.1 |

| Jaeger | 1.30.2 |

| Kiali | 1.36.10-2 |

1.2.2.27. Red Hat OpenShift Service Mesh 2.1.2.1 の新機能

このリリースの Red Hat OpenShift Service Mesh では、CVE (Common Vulnerabilities and Exposures) およびバグ修正に対応しています。

1.2.2.27.1. Red Hat OpenShift Service Mesh バージョン 2.1.2.1 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.9.9 |

| Envoy プロキシー | 1.17.1 |

| Jaeger | 1.30.2 |

| Kiali | 1.36.9 |

1.2.2.28. Red Hat OpenShift Service Mesh 2.1.2 の新機能

このリリースの Red Hat OpenShift Service Mesh では、CVE (Common Vulnerabilities and Exposures) およびバグ修正に対応しています。

このリリースでは、Red Hat 分散トレースプラットフォーム Operator がデフォルトで openshift-distributed-tracing namespace にインストールされるようになりました。以前のリリースでは、デフォルトのインストールは openshift-operator namespace にありました。

1.2.2.28.1. Red Hat OpenShift Service Mesh バージョン 2.1.2 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.9.9 |

| Envoy プロキシー | 1.17.1 |

| Jaeger | 1.30.1 |

| Kiali | 1.36.8 |

1.2.2.29. Red Hat OpenShift Service Mesh 2.1.1 の新機能

このリリースの Red Hat OpenShift Service Mesh では、CVE (Common Vulnerabilities and Exposures) およびバグ修正に対応しています。

このリリースでは、ネットワークポリシーの自動作成を無効にする機能も追加されています。

1.2.2.29.1. Red Hat OpenShift Service Mesh バージョン 2.1.1 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.9.9 |

| Envoy プロキシー | 1.17.1 |

| Jaeger | 1.24.1 |

| Kiali | 1.36.7 |

1.2.2.29.2. ネットワークポリシーの無効化

Red Hat OpenShift Service Mesh は、Service Mesh コントロールプレーンおよびアプリケーションネームスペースで多数の NetworkPolicies リソースを自動的に作成し、管理します。これは、アプリケーションとコントロールプレーンが相互に通信できるようにするために使用されます。

NetworkPolicies リソースの自動作成および管理を無効にする場合 (例: 会社のセキュリティーポリシーを適用する場合など) は、これを実行できます。ServiceMeshControlPlane を編集して spec.security.manageNetworkPolicy 設定を falseに設定できます。

spec.security.manageNetworkPolicy を無効にすると、Red Hat OpenShift Service Mesh は、NetworkPolicy オブジェクトをひとつも作成しません。システム管理者は、ネットワークを管理し、この原因の問題を修正します。

手順

- OpenShift Container Platform Web コンソールで、Operators → Installed Operators をクリックします。

-

Project メニューから、Service Mesh コントロールプレーンをインストールしたプロジェクト (例:

istio-system) を選択します。 -

Red Hat OpenShift Service Mesh Operator をクリックします。Istio Service Mesh Control Plane 列で、

ServiceMeshControlPlaneの名前 (basic-installなど) をクリックします。 -

Create ServiceMeshControlPlane Details ページで、

YAMLをクリックして設定を変更します。 以下の例のように、

ServiceMeshControlPlaneフィールドspec.security.manageNetworkPolicyをfalseに設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Save をクリックします。

1.2.2.30. Red Hat OpenShift Service Mesh 2.1 の新機能および機能拡張

Red Hat OpenShift Service Mesh の本リリースでは、Istio 1.9.8、Envoy Proxy 1.17.1、Jaeger 1.24.1、および Kiali 1.36.5 のサポートと新機能および機能拡張が OpenShift Container Platform 4.6 EUS、4.7、4.8、および 4.9 で追加されました。

1.2.2.30.1. Red Hat OpenShift Service Mesh バージョン 2.1 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.9.6 |

| Envoy プロキシー | 1.17.1 |

| Jaeger | 1.24.1 |

| Kiali | 1.36.5 |

1.2.2.30.2. Service Mesh のフェデレーション

サービスメッシュをフェデレーションできるように新規のカスタムリソース定義 (CRD) が追加されました。サービスメッシュは、同じクラスター内または異なる OpenShift クラスター間でフェデレーションを行うことができます。これらの新規リソースには以下が含まれます。

-

ServiceMeshPeer: ゲートウェイ設定、ルート信頼証明書設定、ステータスフィールドなど、別のサービスメッシュでのフェデレーションを定義します。フェデレーションされたメッシュのペアでは、各メッシュは独自のServiceMeshPeerリソースを個別に定義します。 -

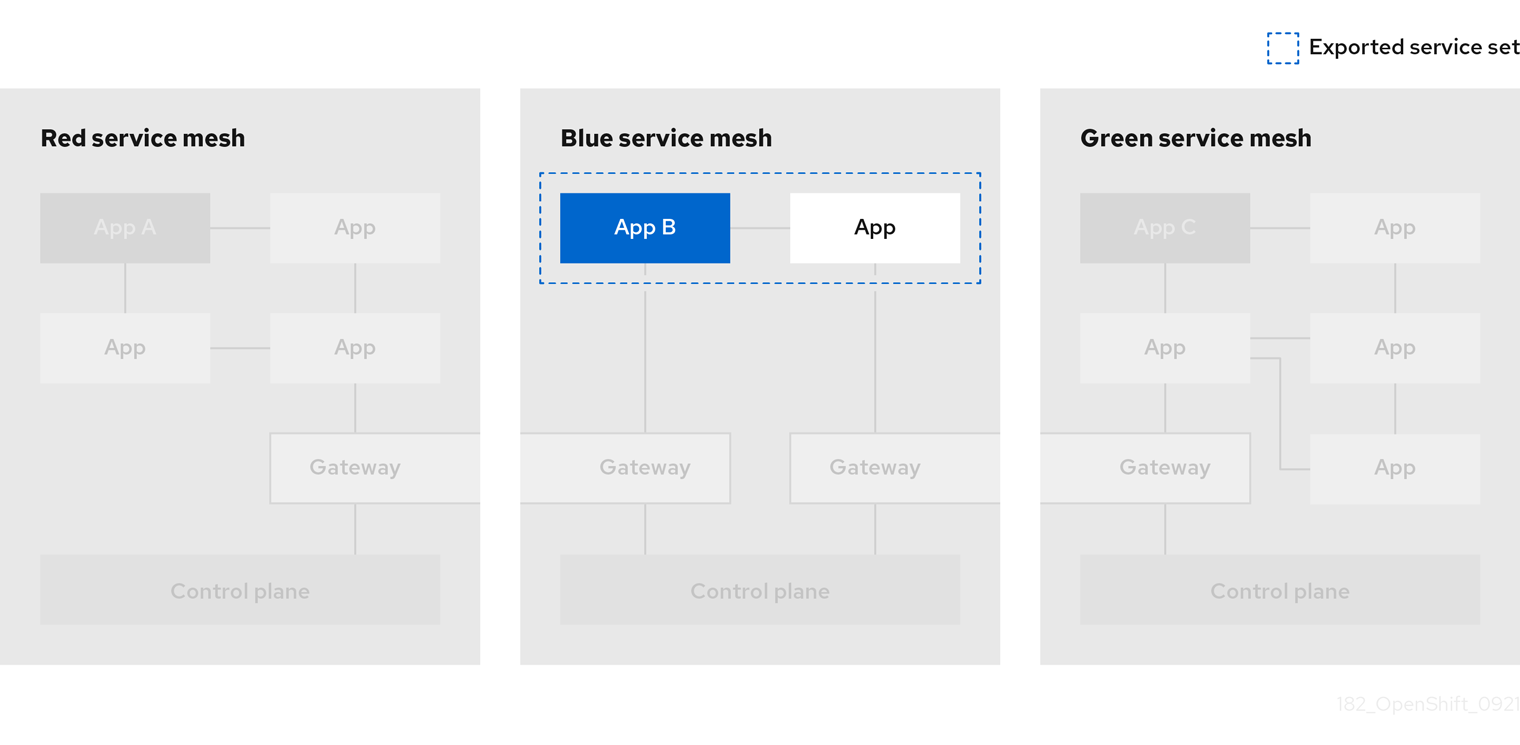

ExportedServiceMeshSet: ピアメッシュのインポートに利用できる特定のServiceMeshPeerサービスを定義します。 -

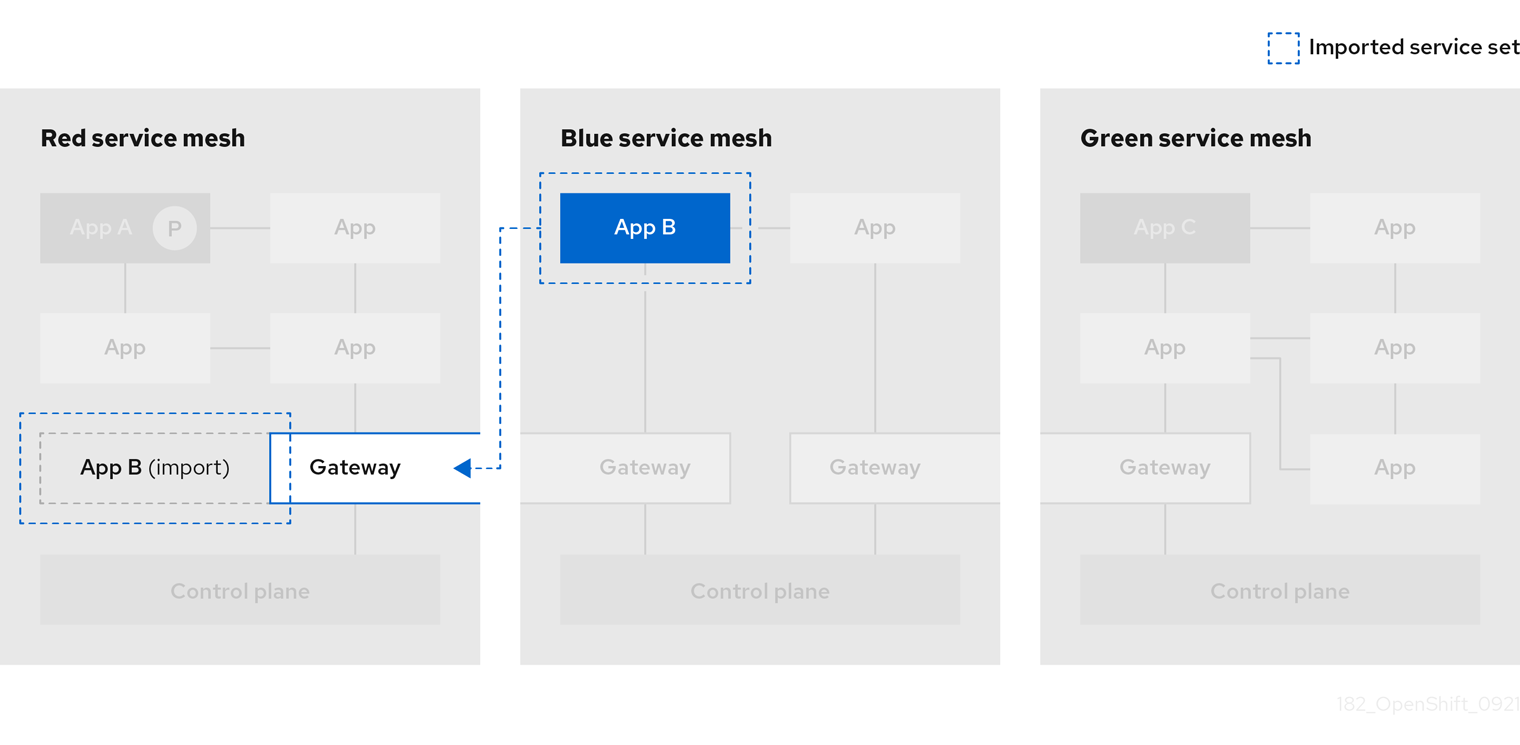

ImportedServiceSet: ピアメッシュからインポートする特定のServiceMeshPeerのサービスを定義します。これらのサービスは、ピアのExportedServiceMeshSetリソースで利用できるようにする必要もあります。

Service Mesh Federation は、Red Hat OpenShift Service on AWS (ROSA)、Azure Red Hat OpenShift (ARO)、または OpenShift Dedicated (OSD) のクラスター間ではサポートされていません。

1.2.2.30.3. OVN-Kubernetes Container Network Interface(CNI) の一般提供

OVN-Kubernetes Container Network Interface(CNI) は、以前は Red Hat OpenShift Service Mesh 2.0.1 のテクノロジープレビュー機能として導入されましたが、OpenShift Container Platform 4.7.32、OpenShift Container Platform 4.8.12、および OpenShift Container Platform 4.9 で使用できるように Red Hat OpenShift Service Mesh 2.1 および 2.0.x で一般提供されています。

1.2.2.30.4. Service Mesh WebAssembly(WASM) 拡張

ServiceMeshExtensions カスタムリソース定義 (CRD) は、最初に 2.0 でテクノロジープレビュー機能として導入され、今回のバージョンで一般公開されました。CRD を使用して独自のプラグインを構築できますが、Red Hat では独自に作成したプラグインはサポートしていません。

Mixer はサービスメッシュ 2.1 で完全に削除されました。Mixer が有効な場合は、Service Mesh 2.0.x リリースから 2.1 へのアップグレードは、ブロックされます。Mixer プラグインは WebAssembly 拡張に移植する必要があります。

1.2.2.30.5. 3scale WebAssembly Adapter (WASM)

Mixer が正式に削除されたため、OpenShift 3scale mixer アダプターは、Service Mesh 2.1 ではサポート対象外となっています。Service Mesh 2.1 にアップグレードする前に、Mixer ベースの 3scale アダプターと追加の Mixer プラグインを削除します。次に、ServiceMeshExtension リソースを使用して、新しい 3scale WebAssembly アダプターを Service Mesh 2.1 以上で手動でインストールして設定します。

3scale 2.11 では、WebAssembly に基づく更新された Service Mesh の統合が導入されました。

1.2.2.30.6. Istio 1.9 サポート

Service Mesh 2.1 は Istio 1.9 をベースとしており、製品の新機能および機能拡張が数多く追加されました。Istio 1.9 の大半の機能がサポートされていますが、以下の例外に注意してください。

- 仮想マシンの統合はまだサポートされていません。

- Kubernetes Gateway API はまだサポートされていません。

- WebAssembly HTTP フィルターのリモートフェッチおよびロードはサポートされていません。

- Kubernetes CSR API を使用したカスタム CA 統合はまだサポートされていません。

- トラフィック監視要求の分類機能はテクノロジープレビュー機能です。

- Authorization ポリシーの CUSTOM アクションによる外部承認システムとの統合はテクノロジープレビュー機能です。

1.2.2.30.7. Service Mesh Operator のパフォーマンス向上

各 ServiceMeshControlPlane の調整の終了時に以前のリソースのプルーニングに使用する期間が短縮されました。これにより、ServiceMeshControlPlane のデプロイメントにかかる時間が短縮され、既存の SMCP に適用される変更がこれまでよりも早く有効になります。

1.2.2.30.8. Kiali の更新

Kiali 1.36 には、以下の機能と拡張機能が含まれています。

Service Mesh のトラブルシューティング機能

- コントロールプレーンおよびゲートウェイの監視

- プロキシーの同期ステータス

- Envoy 設定ビュー

- Envoy プロキシーおよびアプリケーションログのインターリーブを示す統合ビュー

- フェデレーションされたサービスメッシュビューをサポートする namespace およびクラスターボックス

- 新しい検証、ウィザード、および分散トレースの機能拡張

1.2.2.31. Red Hat OpenShift Service Mesh 2.0.11.1 の新機能

Red Hat OpenShift Service Mesh の本リリースでは、CVE (Common Vulnerabilities and Exposures) およびバグ修正に対応し、OpenShift Container Platform 4.9 以降でサポートされます。

1.2.2.31.1. Red Hat OpenShift Service Mesh バージョン 2.0.11.1 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.6.14 |

| Envoy プロキシー | 1.14.5 |

| Jaeger | 1.36 |

| Kiali | 1.24.17 |

1.2.2.32. Red Hat OpenShift Service Mesh 2.0.11 の新機能

Red Hat OpenShift Service Mesh の本リリースでは、CVE (Common Vulnerabilities and Exposures) およびバグ修正に対応し、OpenShift Container Platform 4.9 以降でサポートされます。

1.2.2.32.1. Red Hat OpenShift Service Mesh バージョン 2.0.11 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.6.14 |

| Envoy プロキシー | 1.14.5 |

| Jaeger | 1.36 |

| Kiali | 1.24.16-1 |

1.2.2.33. Red Hat OpenShift Service Mesh 2.0.10 の新機能

このリリースの Red Hat OpenShift Service Mesh では、CVE (Common Vulnerabilities and Exposures) およびバグ修正に対応しています。

1.2.2.33.1. Red Hat OpenShift Service Mesh バージョン 2.0.10 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.6.14 |

| Envoy プロキシー | 1.14.5 |

| Jaeger | 1.28.0 |

| Kiali | 1.24.16-1 |

1.2.2.34. Red Hat OpenShift Service Mesh 2.0.9 の新機能

このリリースの Red Hat OpenShift Service Mesh では、CVE (Common Vulnerabilities and Exposures) およびバグ修正に対応しています。

1.2.2.34.1. Red Hat OpenShift Service Mesh バージョン 2.0.9 に含まれるコンポーネントのバージョン

| コンポーネント | バージョン |

|---|---|

| Istio | 1.6.14 |

| Envoy プロキシー | 1.14.5 |

| Jaeger | 1.24.1 |

| Kiali | 1.24.11 |

1.2.2.35. Red Hat OpenShift Service Mesh 2.0.8 の新機能

このリリースの Red Hat OpenShift Service Mesh では、バグ修正に対応しています。

1.2.2.36. Red Hat OpenShift Service Mesh 2.0.7.1 の新機能

このリリースの Red Hat OpenShift Service Mesh では、CVE (Common Vulnerabilities and Exposures) に対応しています。

1.2.2.36.1. Red Hat OpenShift Service Mesh が URI フラグメントを処理する方法の変更

Red Hat OpenShift Service Mesh には、リモートで悪用可能な脆弱性 CVE-2021-39156 が含まれており、URI パスにフラグメント (URI の末尾が # 文字で始まるセクション) を含む HTTP リクエストが Istio URI パスベースの認証ポリシーを無視する可能性があります。たとえば、Istio 認証ポリシーは URI パス /user/profile に送信される要求を拒否します。脆弱なバージョンでは、URI パス /user/profile#section1 のリクエストは、deny ポリシーと、(正規化された URI path /user/profile%23section1 を使用する) バックエンドへのルートを無視するため、セキュリティーのインシデントにつながる可能性があります。

DENY アクションおよび operation.paths、または ALLOW アクションおよび operation.notPaths で認可ポリシーを使用する場合は、この脆弱性の影響を受けます。

軽減策により、リクエストの URI の断片部分が、承認とルーティングの前に削除されます。これにより、URI のフラグメントを持つ要求が、フラグメントの一部のない URI をベースとする承認ポリシーが無視できなくなります。

軽減策の新しい動作からオプトインするには、URI の fragment セクションが保持されます。ServiceMeshControlPlane を設定して URI フラグメントを保持できます。

新しい動作を無効にすると、上記のようにパスを正規化し、安全でないと見なされます。URI フラグメントを保持することを選択する前に、セキュリティーポリシーでこれに対応していることを確認してください。

ServiceMeshControlPlane の変更例

1.2.2.36.2. 認証ポリシーに必要な更新

Istio はホスト名自体とすべての一致するポートの両方にホスト名を生成します。たとえば、httpbin.foo のホストの仮想サービスまたはゲートウェイは、httpbin.foo and httpbin.foo:* に一致する設定を生成します。ただし、完全一致許可ポリシーは、hosts または notHosts フィールドに指定された完全一致文字列にのみ一致します。

ルールの正確な文字列比較を使用して hosts または notHosts を決定する AuthorizationPolicy リソースがある場合、クラスターは影響を受けます。

完全一致ではなく接頭辞一致を使用するように、認証ポリシー ルール を更新する必要があります。たとえば、最初の AuthorizationPolicy の例で hosts: ["httpbin.com"] を hosts: ["httpbin.com:*"] に置き換えます。

接頭辞一致を使用した最初の AuthorizationPolicy の例

接頭辞一致を使用した 2 つ目の AuthorizationPolicy の例

1.2.2.37. Red Hat OpenShift Service Mesh 2.0.7 の新機能

このリリースの Red Hat OpenShift Service Mesh では、CVE (Common Vulnerabilities and Exposures) およびバグ修正に対応しています。

1.2.2.38. Red Hat OpenShift Dedicated および Microsoft Azure Red Hat OpenShift 上の Red Hat OpenShift Service Mesh

Red Hat OpenShift Service Mesh は、Red Hat OpenShift Dedicated および Microsoft Azure Red Hat OpenShift 経由でサポートされるようになりました。

1.2.2.39. Red Hat OpenShift Service Mesh 2.0.6 の新機能

このリリースの Red Hat OpenShift Service Mesh では、CVE (Common Vulnerabilities and Exposures) およびバグ修正に対応しています。

1.2.2.40. Red Hat OpenShift Service Mesh 2.0.5 の新機能

このリリースの Red Hat OpenShift Service Mesh では、CVE (Common Vulnerabilities and Exposures) およびバグ修正に対応しています。

1.2.2.41. Red Hat OpenShift Service Mesh 2.0.4 の新機能

このリリースの Red Hat OpenShift Service Mesh では、CVE (Common Vulnerabilities and Exposures) およびバグ修正に対応しています。

CVE-2021-29492 および CVE-2021-31920 に対応するために、手動による手順を完了する必要があります。

1.2.2.41.1. CVE-2021-29492 および CVE-2021-31920 で必要な手動による更新

Istio にはリモートで悪用可能な脆弱性があり、複数のスラッシュまたはエスケープされたスラッシュ文字 (%2F または %5C) を持つ HTTP リクエストパスが、パスベースの認証ルールが使用される場合に Istio 認証ポリシーを無視する可能性があります。

たとえば、Istio クラスター管理者が、パス /admin での要求を拒否する認証 DENY ポリシーを定義すると仮定します。URL パス //admin に送信される要求は、認証ポリシーには拒否されません。

RFC 3986 に応じて、複数のスラッシュを持つパス //admin は、/admin とは異なるパスとして処理される必要があります。ただし、一部のバックエンドサービスは、複数のスラッシュを単一のスラッシュにマージして URL パスを正規化することを選択します。これにより、認証ポリシーがバイパスされ (//admin は /admin に一致しない)、ユーザーはバックエンドのパス (/admin) でリソースにアクセスできます。これは、セキュリティーのインシデントを表します。

ALLOW action + notPaths フィールドまたは DENY action + paths field パターンを使用する認証ポリシーがある場合、クラスターはこの脆弱性の影響を受けます。これらのパターンは、予期しないポリシーのバイパスに対して脆弱です。

以下の場合、クラスターはこの脆弱性の影響を受けません。

- 認証ポリシーがありません。

-

認証ポリシーは、

pathsフィールドまたはnotPathsフィールドを定義しません。 -

認証ポリシーは、

ALLOW action + pathsフィールドまたはDENY action + notPathsフィールドのパターンを使用します。これらのパターンは、ポリシーのバイパスではなく、予期しない拒否を生じさせる可能性があります。このような場合、アップグレードは任意です。

パスの正規化向けの Red Hat OpenShift Service Mesh 設定の場所は、Istio 設定とは異なります。

1.2.2.41.2. パスの正規化設定の更新

Istio 認証ポリシーは、HTTP リクエストの URL パスをベースとする場合があります。URI の正規化として知られる パスの正規化 は、正規化されたパスを標準の方法で処理できるように、受信要求のパスを変更し、標準化します。構文の異なるパスは、パスの正規化後と同一になる場合があります。

Istio は、認証ポリシーに対して評価し、要求をルーティングする前の、要求パスでの以下の正規化スキームをサポートします。

| オプション | 説明 | 例 | 注記 |

|---|---|---|---|

|

| 正規化は行われません。Envoy が受信する内容はそのまますべて、どのバックエンドサービスにも完全に転送されます。 |

| この設定は CVE-2021-31920 に対して脆弱です。 |

|

|

現時点で、これは Istio の デフォルト インストールで使用されるオプションです。これにより、Envoy プロキシーで |

| この設定は CVE-2021-31920 に対して脆弱です。 |

|

| スラッシュは BASE の正規化後にマージされます。 |

| この設定に対して更新を行い、CVE-2021-31920 のリスクを軽減します。 |

|

|

デフォルトですべてのトラフィックを許可する場合の最も厳密な設定です。この設定の場合は、認証ポリシーのルートを詳細にテストする必要がある点に注意してください。パーセントでエンコードされた スラッシュおよびバックスラッシュ文字 ( |

| この設定に対して更新を行い、CVE-2021-31920 のリスクを軽減します。この設定はより安全ですが、アプリケーションが破損する可能性があります。実稼働環境にデプロイする前にアプリケーションをテストします。 |

正規化アルゴリズムは以下の順序で実行されます。

-

パーセントでデコードされた

%2F、%2f、%5Cおよび%5c。 -

Envoy の

normalize_pathオプションで実装された RFC 3986 およびその他の正規化。 - スラッシュをマージします。

これらの正規化オプションは HTTP 標準および一般的な業界プラクティスの推奨事項を表しますが、アプリケーションは独自に選択したいずれかの方法で URL を解釈する場合があります。拒否ポリシーを使用する場合は、アプリケーションの動作を把握している必要があります。

1.2.2.41.3. パスの正規化設定の例

Envoy がバックエンドサービスの期待値に一致するように要求パスを正規化することは、システムのセキュリティーを保護する上で非常に重要です。以下の例は、システムを設定するための参考として使用できます。正規化された URL パス、または NONE が選択されている場合、元の URL パスは以下のようになります。

- 認証ポリシーの確認に使用されます。

- バックエンドアプリケーションに転送されます。

| アプリケーションの条件 | 選択内容 |

|---|---|

| プロキシーを使用して正規化を行う。 |

|

| RFC 3986 に基づいて要求パスを正規化し、スラッシュをマージしない。 |

|

| RFC 3986 に基づいて要求パスを正規化し、スラッシュをマージするが、パーセントでエンコードされた スラッシュをデコードしない。 |

|

| RFC 3986 に基づいて要求パスを正規化し、パーセントでエンコードされた スラッシュをデコードし、スラッシュをマージする。 |

|

| RFC 3986 と互換性のない方法で要求パスを処理する。 |

|

1.2.2.41.4. パスを正規化するための SMCP の設定

Red Hat OpenShift Service Mesh のパスの正規化を設定するには、ServiceMeshControlPlane で以下を指定します。設定例を使用すると、システムの設定を判断するのに役立ちます。

SMCP v2 pathNormalization

spec:

techPreview:

global:

pathNormalization: <option>

spec:

techPreview:

global:

pathNormalization: <option>1.2.2.41.5. ケース正規化 (case normalization) の設定

環境によっては、大文字と小文字を区別しない場合の比較用に 2 つのパスを認証ポリシーに用意すると便利な場合があります。たとえば、https://myurl/get と https://myurl/GeT を同等なものとして扱います。このような場合は、以下に示されている EnvoyFilter を使用できます。このフィルターは、比較用に使用されるパスとアプリケーションに表示されるパスの両方を変更します。この例では、istio-system が Service Mesh コントロールプレーンプロジェクトの名前となります。

EnvoyFilter をファイルに保存して、以下のコマンドを実行します。

oc create -f <myEnvoyFilterFile>

$ oc create -f <myEnvoyFilterFile>1.2.2.42. Red Hat OpenShift Service Mesh 2.0.3 の新機能

このリリースの Red Hat OpenShift Service Mesh では、CVE (Common Vulnerabilities and Exposures) およびバグ修正に対応しています。

また、このリリースには以下の新機能があります。

-

指定された Service Mesh コントロールプレーン namespace から情報を収集する

must-gatherデータ収集ツールにオプションが追加されました。詳細は、OSSM-351 を参照してください。 - 数百の namespace が含まれる Service Mesh コントロールプレーンのパフォーマンスの向上

1.2.2.43. Red Hat OpenShift Service Mesh 2.0.2 の新機能

Red Hat OpenShift Service Mesh の本リリースでは、IBM Z および IBM Power Systems のサポートが追加されました。また、CVE (Common Vulnerabilities and Exposures) およびバグ修正に対応しています。

1.2.2.44. Red Hat OpenShift Service Mesh 2.0.1 の新機能

このリリースの Red Hat OpenShift Service Mesh では、CVE (Common Vulnerabilities and Exposures) およびバグ修正に対応しています。

1.2.2.45. Red Hat OpenShift Service Mesh 2.0 の新機能

Red Hat OpenShift Service Mesh の本リリースでは、Istio 1.6.5、Jaeger 1.20.0、Kiali 1.24.2、3scale Istio Adapter 2.0 および OpenShift Container Platform 4.6 のサポートが追加されました。

また、本リリースには以下の新機能があります。

- Service Mesh コントロールプレーンのインストール、アップグレード、および管理を単純化します。

- Service Mesh コントロールプレーンのリソース使用量と起動時間を短縮します。

ネットワークのコントロールプレーン間の通信を削減することで、パフォーマンスが向上します。

- Envoy の Secret Discovery Service (SDS) のサポートが追加されました。SDS は、Envoy サイドカープロキシーにシークレットを提供するためのより安全で効率的なメカニズムです。

- よく知られているセキュリティーリスクがある Kubernetes シークレットを使用する必要性がなくなります。

プロキシーが新しい証明書を認識するのに再起動を必要としなくなったため、証明書のローテーション時にパフォーマンスが向上します。

- WebAssembly 拡張を使用してビルドされる Istio の Telemetry v2 アーキテクチャーのサポートを追加します。この新しいアーキテクチャーにより、パフォーマンスが大幅に改善されました。

- ServiceMeshControlPlane リソースを簡素化された設定を含む v2 に更新し、Service Mesh コントロールプレーンの管理を容易にします。

- WebAssembly 拡張を テクノロジープレビュー として導入します。

1.2.3. テクノロジープレビュー

現在、今回のリリースに含まれる機能にはテクノロジープレビューのものがあります。これらの実験的機能は、実稼働環境での使用を目的としていません。

テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は実稼働環境でこれらを使用することを推奨していません。テクノロジープレビュー機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

1.2.4. 非推奨および削除された機能

以前のリリースで利用可能であった一部の機能が非推奨になるか、削除されました。

非推奨の機能は依然として OpenShift Container Platform に含まれており、引き続きサポートされますが、本製品の今後のリリースで削除されるため、新規デプロイメントでの使用は推奨されません。

本製品では、削除機能が除去されています。

1.2.4.1. Red Hat OpenShift Service Mesh 2.4 で非推奨化および廃止された機能

v2.1 の ServiceMeshControlPlane リソースはサポートされなくなりました。お客様は、新しいバージョンの ServiceMeshControlPlane リソースを使用するようにメッシュデプロイメントをアップグレードする必要があります。

Istio OpenShift Routing (IOR) のサポートは非推奨となり、将来のリリースでは削除される予定です。

Grafana のサポートは非推奨となり、将来のリリースでは削除される予定です。

Red Hat OpenShift Service Mesh 2.3 で非推奨となった以下の暗号スイートのサポートは、クライアント側とサーバー側の両方で TLS ネゴシエーションで使用される暗号のデフォルトのリストから削除されました。これらの暗号スイートのいずれかを必要とするサービスにアクセスする必要があるアプリケーションは、プロキシーから TLS 接続が開始されると接続に失敗します。

- ECDHE-ECDSA-AES128-SHA

- ECDHE-RSA-AES128-SHA

- AES128-GCM-SHA256

- AES128-SHA

- ECDHE-ECDSA-AES256-SHA

- ECDHE-RSA-AES256-SHA

- AES256-GCM-SHA384

- AES256-SHA

1.2.4.2. Red Hat OpenShift Service Mesh 2.3 で非推奨化および廃止された機能

次の暗号スイートのサポートは非推奨になりました。将来のリリースでは、クライアント側とサーバー側の両方で TLS ネゴシエーションに使用されるデフォルトの暗号リストから削除される予定です。

- ECDHE-ECDSA-AES128-SHA

- ECDHE-RSA-AES128-SHA

- AES128-GCM-SHA256

- AES128-SHA

- ECDHE-ECDSA-AES256-SHA

- ECDHE-RSA-AES256-SHA

- AES256-GCM-SHA384

- AES256-SHA

Red Hat OpenShift Service Mesh バージョン 2.2 で非推奨化された ServiceMeshExtension API は、Red Hat OpenShift Service Mesh バージョン 2.3 で廃止されました。ServiceMeshExtension API を使用している場合、WebAssembly エクステンションを引き続き使用するには WasmPlugin API に移行する必要があります。

1.2.4.3. 非推奨になった Red Hat OpenShift Service Mesh 2.2 の機能

ServiceMeshExtension API は、リリース 2.2 で非推奨になり、今後のリリースで削除される予定です。ServiceMeshExtension API はリリース 2.2 でも引き続きサポートされますが、お客様は新しい WasmPluginAPI への移行を開始する必要があります。

1.2.4.4. Red Hat OpenShift Service Mesh 2.2 で削除された機能

このリリースは、すべてのプラットフォームでの Service Mesh 1.1 に基づく Service Mesh コントロールプレーンのサポートの終了を示します。

1.2.4.5. Red Hat OpenShift Service Mesh 2.1 で削除された機能

Service Mesh 2.1 では、Mixer コンポーネントが削除されます。バグ修正およびサポートは、Service Mesh 2.0 の最後のライフサイクルで提供されます。

Mixer プラグインが有効な場合は、Service Mesh 2.0.x リリースから 2.1 へのアップグレードは続行されません。Mixer プラグインは、WebAssembly 拡張に移植する必要があります。

1.2.4.6. 非推奨になった Red Hat OpenShift Service Mesh 2.0 の機能

Mixer コンポーネントはリリース 2.0 で非推奨となり、リリース 2.1 で削除されます。Mixer を使用した拡張機能の実装はリリース 2.0 でも引き続きサポートされますが、拡張機能を新規の WebAssembly メカニズムに移行する必要があります。

以下のリソースタイプは Red Hat OpenShift Service Mesh 2.0 でサポートされなくなりました。

Policy(authentication.istio.io/v1alpha1) はサポートされなくなりました。Policy リソースの特定の設定によっては、同じ効果を実現するために複数のリソースを設定しなければならない場合があります。-

RequestAuthentication(security.istio.io/v1beta1) の使用 -

PeerAuthentication(security.istio.io/v1beta1) の使用

-

ServiceMeshPolicy(maistra.io/v1) はサポートされなくなりました。-

上記のように

RequestAuthenticationまたはPeerAuthenticationを使用しますが、Service Mesh コントロールプレーン namespace に配置します。

-

上記のように

RbacConfig(rbac.istio.io/v1alpha1) はサポートされなくなりました。-

AuthorizationPolicy(security.istio.io/v1beta1) に置き換わります。これはRbacConfig、ServiceRole、およびServiceRoleBindingの動作を包含します。

-

ServiceMeshRbacConfig(maistra.io/v1) がサポートされなくなりました。-

上記のように

AuthorizationPolicyを使用しますが、Service Mesh コントロールプレーンの namespace に配置します。

-

上記のように

-

ServiceRole(rbac.istio.io/v1alpha1) がサポートされなくなりました。 -

ServiceRoleBinding(rbac.istio.io/v1alpha1) がサポートされなくなりました。 -

Kiali では、

loginおよびLDAPストラテジーは非推奨になりました。今後のバージョンでは、OpenID プロバイダーを使用した認証が導入されます。

1.2.5. 既知の問題

Red Hat OpenShift Service Mesh には以下のような制限が存在します。

- Red Hat OpenShift Service Mesh はまだ IPv6 をフルサポートを提供していません。その結果、Red Hat OpenShiftServiceMesh ではデュアルスタッククラスターはサポート対象外です。

- グラフレイアウト: Kiali グラフのレイアウトは、アプリケーションのアーキテクチャーや表示データ (グラフィックノードとその対話の数) によって異なることがあります。すべての状況に適した単一のレイアウトを作成することは不可能ではないにしても困難であるため、Kiali は複数の異なるレイアウトの選択肢を提供します。別のレイアウトを選択するには、Graph Settings メニューから異なる Layout Schema を選択します。

- Kiali コンソールから 分散トレースプラットフォーム や Grafana などの関連サービスに初めてアクセスする場合、OpenShift Container Platform のログイン認証情報を使用して証明書を受け入れ、再認証する必要があります。これは、フレームワークが組み込まれたページをコンソールで表示する方法に問題があるために生じます。

- Bookinfo サンプルアプリケーションは、IBM Power、IBM Z、および {linuxoneProductName} にはインストールできません。

- WebAssembly 拡張機能は、IBM Power、IBM Z、および {linuxoneProductName} ではサポートされていません。

- LuaJIT は、IBM Power、IBM Z、および {linuxoneProductName} ではサポートされていません。

- シングルスタック IPv6 サポートは、IBM Power、IBM Z、および {linuxoneProductName} では利用できません。

1.2.5.1. Service Mesh の既知の問題

Red Hat OpenShift Service Mesh には次のような既知の問題が存在します。

OSSM-3890 マルチテナントメッシュデプロイメントでゲートウェイ API を使用しようとすると、次のようなエラーメッセージが生成されます。

2023-05-02T15:20:42.541034Z error watch error in cluster Kubernetes: failed to list *v1alpha2.TLSRoute: the server could not find the requested resource (get tlsroutes.gateway.networking.k8s.io) 2023-05-02T15:20:42.616450Z info kube controller "gateway.networking.k8s.io/v1alpha2/TCPRoute" is syncing...

2023-05-02T15:20:42.541034Z error watch error in cluster Kubernetes: failed to list *v1alpha2.TLSRoute: the server could not find the requested resource (get tlsroutes.gateway.networking.k8s.io) 2023-05-02T15:20:42.616450Z info kube controller "gateway.networking.k8s.io/v1alpha2/TCPRoute" is syncing...Copy to Clipboard Copied! Toggle word wrap Toggle overflow マルチテナントメッシュデプロイメントでゲートウェイ API をサポートするには、すべてのゲートウェイ API カスタムリソース定義 (CRD) ファイルがクラスター内に存在する必要があります。

マルチテナントメッシュデプロイメントでは、CRD スキャンが無効になり、Istio はクラスター内にどの CRD が存在するかを検出する方法がありません。その結果、Istio はサポートされているすべての Gateway API CRD を監視しようとしますが、それらの CRD の一部が存在しない場合はエラーが生成されます。

Service Mesh 2.3.1 以降のバージョンは、

v1alpha2とv1beta1の両方の CRD をサポートします。したがって、マルチテナントメッシュデプロイメントでゲートウェイ API をサポートするには、両方の CRD バージョンが存在する必要があります。回避策: 次の例では、

kubectl get操作によりv1alpha2およびv1beta1CRD がインストールされます。URL には追加のexperimentalセグメントが含まれており、それに応じて既存のスクリプトが更新されることに注意してください。kubectl get crd gateways.gateway.networking.k8s.io || { kubectl kustomize "github.com/kubernetes-sigs/gateway-api/config/crd/experimental?ref=v0.5.1" | kubectl apply -f -; }$ kubectl get crd gateways.gateway.networking.k8s.io || { kubectl kustomize "github.com/kubernetes-sigs/gateway-api/config/crd/experimental?ref=v0.5.1" | kubectl apply -f -; }Copy to Clipboard Copied! Toggle word wrap Toggle overflow OSSM-2042

defaultという名前の SMCP のデプロイメントが失敗します。SMCP オブジェクトを作成し、そのバージョンフィールドを v2.3 に設定する場合、オブジェクトの名前はdefaultにできません。名前がdefaultの場合、コントロールプレーンはデプロイに失敗し、OpenShift は次のメッセージを含むWarningイベントを生成します。Error processing component mesh-config: error: [mesh-config/templates/telemetryv2_1.6.yaml: Internal error occurred: failed calling webhook "rev.validation.istio.io": Post "https://istiod-default.istio-system.svc:443/validate?timeout=10s": x509: certificate is valid for istiod.istio-system.svc, istiod-remote.istio-system.svc, istio-pilot.istio-system.svc, not istiod-default.istio-system.svc, mesh-config/templates/enable-mesh-permissive.yaml

OSSM-1655 SMCP で

mTLSを有効にした後に、Kiali ダッシュボードにエラーが表示されます。SMCP で

spec.security.controlPlane.mtls設定を有効にすると、Kiali コンソールにエラーメッセージNo subsets definedが表示されます。OSSM-1505 この問題は、OpenShift Container Platform 4.11 で

ServiceMeshExtensionリソースを使用する場合にのみ発生します。OpenShift Container Platform 4.11 でServiceMeshExtensionを使用すると、リソースの準備が整いません。oc describe ServiceMeshExtensionを使用して問題を調べると、stderr: Error creating mount namespace before pivot: function not implementedエラーが表示されます。回避策:

ServiceMeshExtensionは Service Mesh 2.2 で廃止されました。ServiceMeshExtensionからWasmPluginリソースに移行します。詳細は、ServiceMeshExtensionからWasmPluginリソースへの移行を参照してください。-

OSSM-1396 ゲートウェイリソースに

spec.externalIPs設定が含まれていると、ゲートウェイは、ServiceMeshControlPlaneの更新時に再作成されず削除され、再作成されることはありません。 - OSSM-1168 サービスメッシュリソースが単一の YAML ファイルとして作成される場合は、Envoy プロキシーサイドカーが Pod に確実に挿入されません。SMCP、SMMR、およびデプロイメントリソースを個別に作成すると、デプロイメントは想定どおりに機能します。

OSSM-1115

spec.proxyAPI のconcurrencyフィールドが istio-proxy に伝播されませんでした。concurrencyフィールドは、ProxyConfigで設定すると機能します。concurrencyフィールドは、実行するワーカースレッドの数を指定します。フィールドが0に設定されている場合、使用可能なワーカースレッドの数は CPU コアの数と等しくなります。フィールドが設定されていない場合、使用可能なワーカースレッドの数はデフォルトで2になります。次の例では、

concurrencyフィールドが0に設定されています。Copy to Clipboard Copied! Toggle word wrap Toggle overflow OSSM-1052 Service Mesh コントロールプレーンで入力ゲートウェイのサービス

ExternalIPを設定すると、サービスは作成されません。SMCP のスキーマには、サービスのパラメーターがありません。回避策: SMCP 仕様でゲートウェイの作成を無効にして、(サービス、ロール、および RoleBinding など) ゲートウェイのデプロイメントを完全に手動で管理します。

OSSM-882 これは、Service Mesh 2.1 以前に適用されます。namespace は accessible_namespace 一覧にありますが、Kiali UI には表示されません。デフォルトでは、Kiali は kube で始まる namespace を表示しません。これらの namespace は通常内部使用のみであり、メッシュの一部ではないためです。

たとえば、akube-a という名前の namespace を作成し、これを Service Mesh メンバーロールに追加すると、Kiali UI は namespace を表示しません。定義された除外パターンの場合、ソフトウェアは、このパターンで始まるか、そのパターンを含む namespace を除外します。

回避策: Kiali カスタムリソース設定を変更して、設定に接頭辞としてキャレット (^) を追加します。以下に例を示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

MAISTRA-2692 Mixer が削除されると、Service Mesh 2.0.x で定義されたカスタムメトリクスを 2.1 で使用できません。カスタムメトリクスは

EnvoyFilterを使用して設定できます。明示的に文書化されている場合を除き、Red Hat はEnvoyFilter設定をサポートできません。これは、下層の Envoy API と疎結合されており、後方互換性を保持することができないためです。 - MAISTRA-2648 サービスメッシュ拡張機能は現在、IBM Z にデプロイされたメッシュと互換性がありません。

MAISTRA-1959 2.0 への移行 Prometheus の収集 (

spec.addons.prometheus.scrapeがtrueに設定される) は mTLS が有効にされていると機能しません。また、Kiali は、mTLS が無効になっている場合に余分なグラフデータを表示します。この問題は、たとえば、プロキシー設定からポート 15020 を除外して対応できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

MAISTRA-453 新規プロジェクトを作成して Pod を即時にデプロイすると、サイドカーコンテナーの挿入は発生しません。この Operator は Pod の作成前に

maistra.io/member-ofを追加できないため、サイドカーコンテナーの挿入を発生させるには Pod を削除し、再作成する必要があります。 - MAISTRA-158 同じホスト名を参照する複数のゲートウェイを適用すると、すべてのゲートウェイが機能しなくなります。

1.2.5.2. Kiali の既知の問題

Kiali の新たな問題は、Component が Kiali に設定された状態の OpenShift Service Mesh プロジェクトに作成される必要があります。

Kiali の既知の問題は以下のとおりです。

- KIALI-2206 初回の Kiali コンソールへのアクセス時に、Kiali のキャッシュされたブラウザーデータがない場合、Kiali サービスの詳細ページの Metrics タブにある View in Grafana リンクは誤った場所にリダイレクトされます。この問題は、Kiali への初回アクセス時にのみ生じます。

- KIALI-507 Kiali は Internet Explorer 11 に対応していません。これは、基礎となるフレームワークが Internet Explorer に対応していないためです。Kiali コンソールにアクセスするには、Chrome、Edge、Firefox、または Safari ブラウザーの最新の 2 バージョンのいずれかを使用します。

1.2.5.3. Red Hat OpenShift 分散トレースの既知の問題

Red Hat OpenShift 分散トレースには、以下の制限があります。

- Apache Spark はサポートされていません。

- AMQ/Kafka 経由のストリーミングデプロイメントは、IBM Z および IBM Power Systems ではサポートされません。

これらは Red Hat OpenShift 分散トレースの既知の問題です。

-

OBSDA-220 分散トレースデータコレクションを使用してイメージをプルしようとすると、イメージのプルが失敗し、

Failed to pull imageエラーメッセージが表示される場合があります。この問題に対する回避策はありません。 TRACING-2057 Kafka API が

v1beta2に更新され、Strimzi Kafka Operator 0.23.0 がサポートされるようになりました。ただし、この API バージョンは AMQ Streams 1.6.3 ではサポートされません。以下の環境がある場合、Jaeger サービスはアップグレードされず、新規の Jaeger サービスを作成したり、既存の Jaeger サービスを変更したりすることはできません。- Jaeger Operator チャネル: 1.17.x stable または 1.20.x stable

AMQ Streams Operator チャネル: amq-streams-1.6.x

この問題を解決するには、AMQ Streams Operator のサブスクリプションチャネルを amq-streams-1.7.x または stable のいずれかに切り替えます。

1.2.6. 修正された問題

次の問題は、現在のリリースで解決されています。

1.2.6.1. Service Mesh の修正された問題

OSSM-4197 では、ServiceMeshControlPlane リソースの v2.2 または v2.1 をデプロイしても、

/etc/cni/multus/net.d/ディレクトリーは作成されませんでした。その結果、istio-cniPod の準備ができず、istio-cniPod のログに次のメッセージが含まれていました。error Installer exits with open /host/etc/cni/multus/net.d/v2-2-istio-cni.kubeconfig.tmp.841118073: no such file or directory

$ error Installer exits with open /host/etc/cni/multus/net.d/v2-2-istio-cni.kubeconfig.tmp.841118073: no such file or directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow ここで、ServiceMeshControlPlane リソースの v2.2 または v2.1 をデプロイすると、

/etc/cni/multus/net.d/ディレクトリーが作成され、istio-cniPod の準備が整います。-

OSSM-3993 以前は、Kiali は標準 HTTPS ポート

443上のプロキシー経由の OpenShift OAuth のみをサポートしていました。現在、Kiali は非標準の HTTPS ポートを介した OpenShift OAuth をサポートします。ポートを有効にするには、Kiali CR でspec.server.web_portフィールドをプロキシーの非標準 HTTPS ポートに設定する必要があります。 -

OSSM-3936 以前は、

injection_label_revおよびinjection_label_name属性の値がハードコーディングされていました。これにより、カスタム設定が Kiali カスタムリソース定義 (CRD) で有効になりませんでした。今回のリリースより、属性値はハードコーディングされなくなりました。spec.istio_labels仕様のinjection_label_revおよびinjection_label_name属性の値をカスタマイズできます。 - OSSM-3644 これまで、フェデレーション egress-gateway はネットワークゲートウェイエンドポイントの誤った更新を受信し、余分なエンドポイントエントリーが発生していました。これで、egress-gateway ゲートウェイはサーバー側で更新され、正しいネットワークゲートウェイエンドポイントを受信できるようになりました。

-

OSSM-3595 これまでは、

iptables-restoreユーティリティーが/tmpディレクトリー内のファイルを開くことを SELinux が許可しなかったため、RHEL 上でistio-cniプラグインが失敗することがありました。SELinux は、ファイル経由ではなくstdin入力ストリーム経由でiptables-restoreを渡すようになりました。 - OSSM-3586 以前は、Google Cloud Platform (GCP) メタデータサーバーが利用できない場合に Istio プロキシーの起動が遅くなりました。Istio 1.14.6 にアップグレードすると、メタデータサーバーが利用できない場合でも、Istio プロキシーは GCP 上で期待どおりに起動します。

- OSSM-3025 Istiod が準備完了にならないことがあります。メッシュに多くのメンバーの namespace が含まれている場合は、Istiod 内のデッドロックが原因で Istiod Pod が準備完了にならないことがありました。デッドロックが解決され、Pod が期待どおりに起動するようになりました。

-

OSSM-2493 SMCP のデフォルトの

nodeSelectorとtolerationsが Kiali に渡されません。SMCP.spec.runtime.defaultsに追加するnodeSelectorとtolerationsが Kiali リソースに渡されるようになりました。 -

OSSM-2492 SMCP のデフォルトの Toleration が Jaeger に渡されません。

SMCP.spec.runtime.defaultsに追加するnodeSelectorとtolerationsが Jaeger リソースに渡されるようになりました。 -

OSSM-2374

ServiceMeshMemberリソースの 1 つを削除すると、サービスメッシュ Operator がServiceMeshMemberRollを削除しました。これは、最後のServiceMeshMemberを削除する際に期待される動作ですが、削除されたメンバーに加えて、メンバーが含まれている場合、Operator はServiceMeshMemberRollを削除しないようにする必要があります。この問題は修正され、Operator は最後のServiceMeshMemberリソースが削除された場合のみ、ServiceMeshMemberRoll を削除するようになりました。 OSSM-2373 ログイン時に OAuth メタデータを取得しようとして、エラーが発生しました。クラスターのバージョンを取得するには、

system:anonymousアカウントが使用されます。クラスターの既定のバンドルされた ClusterRole と ClusterRoleBinding を使用すると、匿名アカウントはバージョンを正しく取得できます。system:anonymousアカウントがクラスターバージョンを取得する権限を失うと、OpenShift 認証は使用できなくなります。これは、Kiali SA を使用して、クラスターのバージョンを取得することで修正されます。これにより、クラスターのセキュリティーも向上します。

- OSSM-2371 Kiali が view-only として設定されているにもかかわらず、ユーザーはワークロードの詳細の Logs タブの kebab メニューからプロキシーログレベルを変更できます。この問題は修正されており、Kiali が view-only として設定されている場合は、Set Proxy Log Level の下のオプションが無効になります。

- OSSM-2344 Istiod を再起動すると、Kiali によって CRI-O がポート転送リクエストでいっぱいになります。この問題は、Kiali が Istiod に接続できず、Kiali が同時に大量のリクエストを istiod に発行したときに発生しました。Kiali が istiod に送信するリクエストの数が制限されるようになりました。

- OSSM-2335 Traces の散布図のプロット上でマウスポインターをドラッグすると、同時バックエンドリクエストが原因で Kiali コンソールが応答を停止する場合がありました。

OSSM-2221 以前は、デフォルトで

ignore-namespaceラベルが名前空間に適用されていたため、ServiceMeshControlPlane名前空間へのゲートウェイインジェクションはできませんでした。v2.4 コントロールプレーンを作成すると、名前空間に

ignore-namespaceラベルが適用されなくなり、ゲートウェイインジェクションが可能になります。以下の例では、

oc labelコマンドは既存のデプロイメントの namespace からignore-namespaceラベルを削除します。oc label namespace <istio_system> maistra.io/ignore-namespace-

$ oc label namespace <istio_system> maistra.io/ignore-namespace-Copy to Clipboard Copied! Toggle word wrap Toggle overflow 上の例では、<istio_system> は

ServiceMeshControlPlanenamespace の名前を表します。OSSM-2053 Red Hat OpenShift Service Mesh Operator 2.2 または 2.3 を使用すると、SMCP の調整中に、SMMR コントローラーがメンバーの namespace を

SMMR.status.configuredMembersから削除しました。これにより、メンバーの namespace のサービスがしばらく利用できなくなりました。Red Hat OpenShift Service Mesh Operator 2.2 または 2.3 を使用すると、SMMR コントローラーは

SMMR.status.configuredMembersから namespace を削除しなくなります。代わりに、コントローラーは namespace をSMMR.status.pendingMembersに追加して、それらが最新ではないことを示します。調整中に、各 namespace が SMCP と同期されると、namespace はSMMR.status.pendingMembersから自動的に削除されます。-

OSSM-1962 フェデレーションコントローラーで

EndpointSlicesを使用します。フェデレーションコントローラーがEndpointSlicesを使用するようになりました。これにより、大規模なデプロイメントでのスケーラビリティとパフォーマンスが向上します。PILOT_USE_ENDPOINT_SLICE フラグはデフォルトで有効になっています。フラグを無効にすると、フェデレーションデプロイメントを使用できなくなります。 -

OSSM-1668 新しいフィールド

spec.security.jwksResolverCAがバージョン 2.1SMCPに追加されましたが、2.2.0 および 2.2.1 リリースにはありませんでした。このフィールドが存在する Operator バージョンから、このフィールドが存在しなかった Operator バージョンにアップグレードする場合は、SMCPで.spec.security.jwksResolverCAフィールドを使用できませんでした。 -

OSSM-1325 istiod Pod がクラッシュし、

fatal error: concurrent map iteration and map writeのエラーメッセージが表示されます。 OSSM-1211 フェールオーバー用のフェデレーションサービスメッシュの設定が想定どおりに機能しません。

Istiod パイロットログに、

envoy connection [C289] TLS error: 337047686:SSL routines:tls_process_server_certificate:certificate verify failedのエラーが表示されます。-

OSSM-1099 Kiali コンソールに

Sorry, there was a problem.Try a refresh or navigate to a different page.メッセージが表示されました - OSSM-1074 SMCP で定義された Pod アノテーションが Pod に注入されません。

- OSSM-999 Kiali は想定どおりに保持されませんでした。ダッシュボードグラフでは、カレンダーの時刻がグレーアウトされています。

-

OSSM-797 Kiali Operator Pod は、Operator のインストールまたはアップグレード時に

CreateContainerConfigErrorを生成します。 -

kubeで始まる OSSM-722 namespace は Kiali には表示されません。 -

OSSM-569: Prometheus

istio-proxyコンテナーには CPU メモリー制限がありません。Prometheusistio-proxyサイドカーは、spec.proxy.runtime.containerで定義されたリソース制限を使用するようになりました。 -

OSSM-535 SMCP での validationMessages のサポート。Service Mesh コントロールプレーンの

ValidationMessagesフィールドをTrueに設定できるようになりました。これにより、問題のトラブルシューティングに役立つ、リソースのステータスのログが書き込まれます。 - OSSM-449 VirtualService および Service により、"Only unique values for domains are permitted.Duplicate entry of domain." エラーが生じます。

- 同様の名前を持つ OSSM-419 namespace は、namespace が Service Mesh Member Role で定義されていない場合でも、Kiali namespace の一覧に表示されます。

- OSSM-296 ヘルス設定を Kiali カスタムリソース (CR) に追加する場合、これは Kiali configmap にレプリケートされません。

- OSSM-291 Kiali コンソールの、Applications、Services、および Workloads ページの Remove Label from Filters が機能しません。

- OSSM-289 Kiali コンソールの istio-ingressgateway および jaeger-query サービスの Service Details ページにはトレースが表示されません。トレースは Jaeger にあります。

- OSSM-287 Kiali コンソールでは、トレースが Graph Service に表示されません。

OSSM-285 Kiali コンソールにアクセスしようとすると、Error trying to get OAuth Metadata エラーメッセージが表示されます。

回避策: Kiali Pod を再起動します。

MAISTRA-2735 Red Hat OpenShift Service Mesh バージョン 2.1 では、SMCP の調整時に Service Mesh Operator が削除するリソースが変更されました。以前のバージョンでは、Operator は以下のラベルを持つリソースを削除しました。

-

maistra.io/owner -

app.kubernetes.io/version

Operator は

app.kubernetes.io/managed-by=maistra-istio-operatorラベルを含まないリソースを無視するようになりました。独自のリソースを作成する場合は、app.kubernetes.io/managed-by=maistra-istio-operatorラベルをそれらに追加することはできません。-

-

MAISTRA-2687 外部証明書を使用する場合は、Red Hat OpenShift Service Mesh 2.1 フェデレーションゲートウェイでは、証明書チェーンが完全に送信されません。Service Mesh フェデレーション egress ゲートウェイはクライアント証明書のみを送信します。フェデレーション Ingress ゲートウェイはルート証明書のみを認識するため、ルート証明書をフェデレーションインポート

ConfigMapに追加しない限り、クライアント証明書を検証できません。 -

MAISTRA-2635 非推奨の Kubernetes API が置き換えられました。OpenShift Container Platform 4.8 との互換性を維持するために、

apiextensions.k8s.io/v1beta1API は Red Hat OpenShift Service Mesh 2.0.8 で非推奨になりました。 -

MAISTRA-2631 nsenter バイナリーが存在しないことが原因で Podman に問題が発生しているため、WASM 機能は使用できません。Red Hat OpenShift Service Mesh は

Error: error configuring CNI network plugin exec: "nsenter": executable file not found in $PATHエラーメッセージを生成します。コンテナーイメージには nsenter が含まれ、WASM が予想通りに機能するようになりました。 - MAISTRA-2534 istiod が JWT ルールで指定された発行者の JWKS の取得を試行する際に、発行者サービスは 502 で応答します。これにより、プロキシーコンテナーの準備ができなくなり、デプロイメントがハングしていました。コミュニティーバグ の修正は、Service Mesh 2.0.7 リリースに含まれています。

MAISTRA-2411 Operator が

ServiceMeshControlPlaneでspec.gateways.additionaIngressを使用して新規 ingress ゲートウェイを作成する場合、Operator はデフォルトの istio-ingressgateway の場合と同様に追加の Ingress ゲートウェイのNetworkPolicyを作成しません。これにより、新規ゲートウェイのルートから 503 応答が生じました。回避策: <istio-system> namespace に

NetworkPolicyを手動で作成します。MAISTRA-2401 CVE-2021-3586 servicemesh-operator: NetworkPolicy リソースが Ingress リソースのポートを誤って指定しています。Red Hat OpenShift Service Mesh にインストールされた NetworkPolicy リソースでは、アクセス可能なポートが適切に指定されませんでした。これにより、任意の Pod からこれらのリソースの全ポートにアクセスできるようになりました。以下のリソースに適用されるネットワークポリシーが影響を受けます。

- Galley

- Grafana

- Istiod

- Jaeger

- Kiali

- Prometheus

- サイドカーインジェクター

-

MAISTRA-2378: クラスターが

ovs-multitenantで OpenShift SDN を使用するように設定されており、メッシュに多数の namespace (200+) が含まれる場合に、OpenShift Container Platform ネットワークプラグインは namespace を迅速に設定できません。Service Mesh がタイムアウトすると、namespace がサービスメッシュから継続的にドロップされ、再リストされます。 - MAISTRA-2370 は listerInformer で tombstones を処理します。更新されたキャッシュコードベースは、namespace キャッシュからのイベントを集約されたキャッシュに変換する際に tombstones を処理しないため、go ルーチンでパニックが生じました。

MAISTRA-2117 オプションの

ConfigMapマウントを Operator に追加します。CSV にはオプションのConfigMapボリュームマウントが含まれるようになり、smcp-templatesConfigMap(存在する場合) をマウントします。smcp-templatesConfigMapが存在しないと、マウントされたディレクトリーは空になります。ConfigMapを作成すると、ディレクトリーにはConfigMapからのエントリーが設定され、SMCP.spec.profilesで参照できます。Service Mesh Operator の再起動は必要ありません。CSV を変更して 2.0 Operator を使用して smcp-templates ConfigMap をマウントしている場合は、Red Hat OpenShift Service Mesh 2.1 にアップグレードできます。アップグレード後は、CSV を編集せずに、既存の ConfigMap およびこれに含まれるプロファイルを引き続き使用できます。以前別の名前で ConfigMap を使用していた場合は、ConfigMap の名前を変更するか、アップグレード後に CSV を更新する必要があります。

-

MAISTRA-2010 AuthorizationPolicy は

request.regex.headersフィールドをサポートしません。validatingwebhookはこのフィールドのある AuthorizationPolicy を拒否し、これを無効にした場合でも、パイロットは同じコードを使用してこの検証を試行し、機能しません。 MAISTRA-1979 2.0 への移行 変換 webhook は、

SMCP.statusを v2 から v1 に変換する際に以下の重要なフィールドをドロップします。- conditions

- components

- observedGeneration

annotations

Operator を 2.0 にアップグレードすると、リソースの maistra.io/v1 バージョンを使用する SMCP ステータスを読み取るクライアントツールが破損する可能性があります。

また、

oc get servicemeshcontrolplanes.v1.maistra.ioの実行時に READY および STATUS 列が空になります。

MAISTRA-1947 テクノロジープレビュー ServiceMeshExtensions への更新は適用されません。

回避策:

ServiceMeshExtensionsを削除し、再作成します。-

MAISTRA-1983 2.0 への移行 既存の無効な

ServiceMeshControlPlaneを使用した 2.0.0 へのアップグレードは修復できません。ServiceMeshControlPlaneリソース内の無効な項目により、回復不可能なエラーが発生しました。修正により、エラーが回復可能になりました。無効なリソースを削除してこれを新しいリソースに置き換えるか、リソースを編集してエラーを修正できます。リソースの編集に関する詳細は、 [Red Hat OpenShift Service Mesh インストールの設定] を参照してください。 - MAISTRA-1502 バージョン 1.0.10 の CVE の修正により、Istio ダッシュボードは Grafana の Home Dashboard メニューから利用できなくなりました。Istio ダッシュボードにアクセスするには、ナビゲーションパネルの Dashboard メニューをクリックし、Manage タブを選択します。

- MAISTRA-1399 Red Hat OpenShift Service Mesh では、サポート対象外の CNI プロトコルがインストールされなくなりました。サポート対象のネットワーク設定は変更されていません。

- MAISTRA-1089 2.0 への移行 コントロールプレーン以外の namespace で作成されたゲートウェイは自動的に削除されます。SMCP 仕様からゲートウェイ定義を削除した後にこれらのリソースを手動で削除する必要があります。

MAISTRA-858 Istio 1.1.x に関連する非推奨のオプションと設定 を説明する以下のような Envoy ログメッセージが予想されます。

- [2019-06-03 07:03:28.943][19][warning][misc] [external/envoy/source/common/protobuf/utility.cc:129] 非推奨の 'envoy.api.v2.listener.Filter.config' オプションの使用。この設定はまもなく Envoy から削除されます。

- [2019-08-12 22:12:59.001][13][warning][misc] [external/envoy/source/common/protobuf/utility.cc:174] lds.proto ファイルから非推奨の 'envoy.api.v2.Listener.use_original_dst' オプションを使用。この設定はまもなく Envoy から削除されます。

MAISTRA-806 エビクトされた Istio Operator Pod により、メッシュおよび CNI はデプロイできなくなります。

回避策: コントロールペインのデプロイ時に

istio-operatorPod がエビクトされる場合は、エビクトされたistio-operatorPod を削除します。- MAISTRA-681 Service Mesh コントロールプレーンに多くの namespace がある場合に、パフォーマンスの問題が発生する可能性があります。

- MAISTRA-193 ヘルスチェックが citadel で有効になっていると、予期しないコンソール情報メッセージが表示されます。

- Bugzilla 1821432: OpenShift Container Platform カスタムリソースの詳細ページのトグルコントロールで CR が正しく更新されません。OpenShift Container Platform Web コンソールの Service Mesh Control Plane (SMCP) Overview ページの UI のトグルコントロールにより、リソースの誤ったフィールドが更新されることがあります。SMCP を更新するには、YAML コンテンツを直接編集するか、トグルコントロールをクリックせずにコマンドラインからリソースを更新します。

1.2.6.2. Red Hat OpenShift 分散トレースの修正された問題

- OSSM-1910 バージョン 2.6 で導入された問題により、OpenShift Container Platform Service Mesh で TLS 接続を確立できませんでした。今回の更新では、OpenShift Container Platform Service Mesh および Istio で使用される規則に一致するようにサービスポート名を変更することで、問題を解決します。

- OBSDA-208 この更新の前は、デフォルトの 200m CPU および 256Mi メモリーリソース制限により、大規模なクラスターで分散トレーシングデータ収集が継続的に再開される可能性がありました。この更新プログラムは、これらのリソース制限を削除することで問題を解決します。

- OBSDA-222 この更新の前は、OpenShift Container Platform 分散トレースプラットフォームでスパンがドロップされる可能性がありました。この問題の発生を防ぐために、このリリースではバージョンの依存関係が更新されています。

TRACING-2337 Jaeger が、Jaeger ログに以下のような警告メッセージを繰り返しロギングします。

{"level":"warn","ts":1642438880.918793,"caller":"channelz/logging.go:62","msg":"[core]grpc: Server.Serve failed to create ServerTransport: connection error: desc = \"transport: http2Server.HandleStreams received bogus greeting from client: \\\"\\\\x16\\\\x03\\\\x01\\\\x02\\\\x00\\\\x01\\\\x00\\\\x01\\\\xfc\\\\x03\\\\x03vw\\\\x1a\\\\xc9T\\\\xe7\\\\xdaCj\\\\xb7\\\\x8dK\\\\xa6\\\"\"","system":"grpc","grpc_log":true}{"level":"warn","ts":1642438880.918793,"caller":"channelz/logging.go:62","msg":"[core]grpc: Server.Serve failed to create ServerTransport: connection error: desc = \"transport: http2Server.HandleStreams received bogus greeting from client: \\\"\\\\x16\\\\x03\\\\x01\\\\x02\\\\x00\\\\x01\\\\x00\\\\x01\\\\xfc\\\\x03\\\\x03vw\\\\x1a\\\\xc9T\\\\xe7\\\\xdaCj\\\\xb7\\\\x8dK\\\\xa6\\\"\"","system":"grpc","grpc_log":true}Copy to Clipboard Copied! Toggle word wrap Toggle overflow この問題は、gRPC ポートではなく、クエリーサービスの HTTP(S) ポートのみを公開することで解決されました。

- TRACING-2009 Jaeger Operator が Strimzi Kafka Operator 0.23.0 のサポートを追加するように更新されました。

-

TRACING-1907: アプリケーション namespace に Config Map がないため、Jaeger エージェントサイドカーの挿入が失敗していました。Config Map は間違った

OwnerReferenceフィールドの設定により自動的に削除され、そのため、アプリケーション Pod は ContainerCreating ステージから移動しませんでした。誤った設定が削除されました。 - TRACING-1725 は TRACING-1631 に対応しています。これはもう 1 つの修正であり、同じ名前だが異なる namespace にある複数の Jaeger 実稼働インスタンスがある場合に Elasticsearch 証明書を適切に調整できるようになりました。BZ-1918920 も参照してください。

- TRACING-1631 同じ名前を使用するが、異なる namespace 内にある複数の Jaeger 実稼働インスタンスを使用すると、Elasticsearch 証明書に問題が発生します。複数のサービスメッシュがインストールされている場合は、すべての Jaeger Elasticsearch インスタンスが個別のシークレットではなく同じ Elasticsearch シークレットを持っていたため、OpenShift Elasticsearch Operator がすべての Elasticsearch クラスターと通信できなくなりました。

- TRACING-1300 Istio サイドカーの使用時に、Agent と Collector 間の接続に失敗しました。Jaeger Operator で有効になっている TLS 通信の更新は、Jaeger サイドカーエージェントと Jaeger Collector 間でデフォルトで提供されます。

-

TRACING-1208 Jaeger UI にアクセスする際に、認証の 500 Internal Error が出力されます。OAuth を使用して UI に対する認証を試行すると、oauth-proxy サイドカーが

additionalTrustBundleでインストール時に定義されたカスタム CA バンドルを信頼しないため、500 エラーが出力されます。 -

TRACING-1166 現時点で、Jaeger ストリーミングストラテジーを非接続環境で使用することはできません。Kafka クラスターがプロビジョニングされる際に、

Failed to pull image registry.redhat.io/amq7/amq-streams-kafka-24-rhel7@sha256:f9ceca004f1b7dccb3b82d9a8027961f9fe4104e0ed69752c0bdd8078b4a1076のエラーが出力されます。 - Trace-809 Jaeger Ingester には Kafka 2.3 との互換性がありません。Jaeger Ingester のインスタンスが複数あり、十分なトラフィックがある場合は、リバランスメッセージがログに継続的に生成されます。これは、Kafka 2.3.1 で修正された Kafka 2.3 のリグレッションによって生じます。詳細は、Jaegertracing-1819 を参照してください。

BZ-1918920/LOG-1619 Elasticsearch Pod は更新後に自動的に再起動しません。

回避策: Pod を手動で再起動します。

1.3. Service Mesh について

Red Hat OpenShift Service Mesh は、サービスメッシュにおいてネットワーク化されたマイクロサービス全体の動作に関する洞察と運用管理のためのプラットフォームを提供します。Red Hat OpenShift Service Mesh では、OpenShift Container Platform 環境でマイクロサービスの接続、保護、監視を行うことができます。

1.3.1. サービスメッシュについて

サービスメッシュ は、分散したマイクロサービスアーキテクチャーの複数のアプリケーションを設定するマイクロサービスのネットワークであり、マイクロサービス間の対話を可能にします。Service Mesh のサイズとおよび複雑性が増大すると、これを把握し、管理することがより困難になる可能性があります。

オープンソースの Istio プロジェクトをベースとする Red Hat OpenShift Service Mesh は、サービスコードに変更を加えずに、既存の分散したアプリケーションに透過的な層を追加します。Red Hat OpenShift Service Mesh サポートをサービスに追加するには、マイクロサービス間のすべてのネットワーク通信を傍受する特別なサイドカープロキシーをメッシュ内の関連サービスにデプロイします。Service Mesh コントロールプレーンの機能を使用して Service Mesh を設定し、管理します。

Red Hat OpenShift Service Mesh により、以下を提供するデプロイされたサービスのネットワークを簡単に作成できます。

- 検出

- 負荷分散

- サービス間の認証

- 障害回復

- メトリクス

- モニタリング

Red Hat OpenShift Service Mesh は、以下を含むより複雑な運用機能も提供します。

- A/B テスト

- カナリアリリース

- アクセス制御

- エンドツーエンド認証

1.3.2. Service Mesh アーキテクチャー

サービスメッシュテクノロジーはネットワーク通信レベルで動作します。つまり、サービスメッシュコンポーネントは、マイクロサービスとの間のトラフィックを取得または傍受して、リクエストを変更したり、リダイレクトしたり、他のサービスへの新しいリクエストを作成したりします。

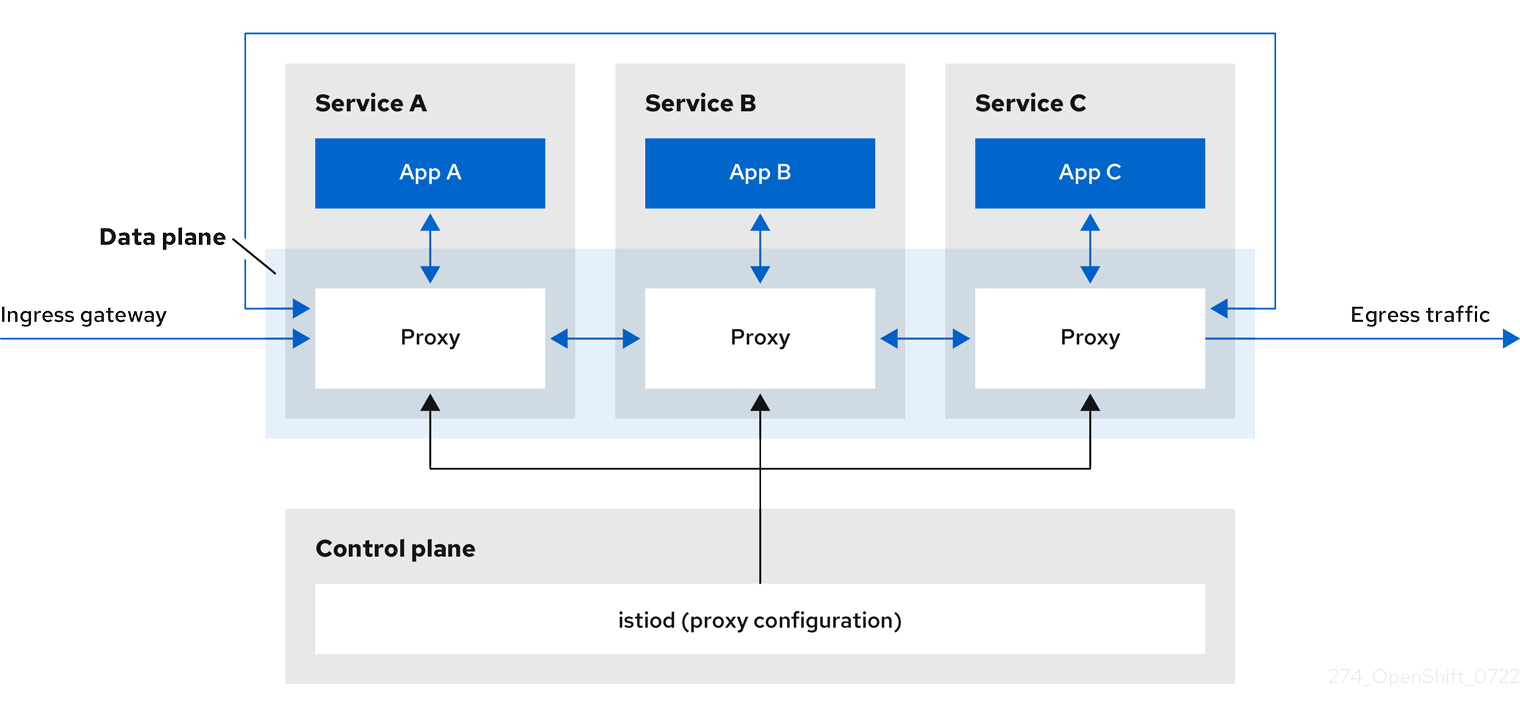

高いレベルでは、Red Hat OpenShift Service Mesh はデータプレーンおよびコントロールプレーンで設定されます。

データプレーン は、Pod のアプリケーションコンテナーとともに実行するインテリジェントプロキシーのセットであり、サービスメッシュ内のマイクロサービス間で起こる受信および送信ネットワーク通信をすべて傍受し、制御します。データプレーンは、すべての受信 (ingress) および送信 (egress) ネットワークトラフィックを傍受する方法で実装されます。Istio データプレーンは、Pod のサイドアプリケーションコンテナーで実行する Envoy コンテナーで設定されます。Envoy コンテナーはプロキシーとして機能し、すべてのネットワーク通信を Pod に対して制御します。

Envoy プロキシー は、データプレーントラフィックと対話する唯一の Istio コンポーネントです。プロキシー経由でサービスフロー間の受信 (ingress) および送信 (egress) ネットワークトラフィックはすべて、そのプロキシーを介して行われます。また、Envoy プロキシーは、メッシュ内のサービストラフィックに関連するすべてのメトリクスを収集します。Envoy プロキシーはサイドカーとしてデプロイされ、サービスと同じ Pod で実行されます。Envoy プロキシーは、メッシュゲートウェイの実装にも使用されます。

- Sidecar プロキシー は、ワークロードインスタンスのインバウンドおよびアウトバウンド通信を管理します。

ゲートウェイ は、受信または送信 HTTP/TCP 接続を受信するロードバランサーとして動作するプロキシーです。ゲートウェイ設定は、サービスワークロードとともに実行するサイドカー Envoy プロキシーではなく、メッシュのエッジで実行するスタンドアロン Envoy プロキシーに適用されます。ゲートウェイを使用してメッシュの受信トラフィックおよび送信トラフィックを管理することで、メッシュに入るか、メッシュを出るトラフィックを指定できます。

- Ingress-gateway - ingress コントローラーとしても知られる、Ingress ゲートウェイはサービスメッシュに入るトラフィックを受信し、制御する専用の Envoy プロキシーです。Ingress ゲートウェイは、モニタリングおよびルーティングルールなどの機能をクラスターに入るトラフィックに適用できるようにします。

- Egress-gateway - egress コントローラーとしても知られる、Egress Gateway はサービスメッシュからトラフィックを管理する専用の Envoy プロキシーです。Egress Gateway は、モニタリングおよびルートルールなどの機能をメッシュのトラフィックに適用できるようにします。

コントロールプレーン は、データプレーンを設定するプロキシーを管理し、設定します。これは、設定用の権威ソースで、アクセス制御および使用状況ポリシーを管理し、サービスメッシュのプロキシーからメトリクスを収集します。

Istio コントロールプレーンは、以前の複数のコントロールプレーンコンポーネント (Citadel、Galley、Pilot) を単一バイナリーに統合する Istiod で設定されています。Istiod は、サービス検出、設定、および証明書の管理を行います。これは、高レベルのルーティングルールを Envoy 設定に変換し、それらをランタイム時にサイドカーコンテナーに伝播します。

- Istiod は認証局 (CA) として機能し、データプレーンでセキュアな mTLS 通信に対応する証明書を生成します。この場合は、外部 CA を使用することもできます。

- Istiod は、サイドカーコンテナーを OpenShift クラスターにデプロイされたワークロードに挿入します。

Red Hat OpenShift Service Mesh は、istio-operator を使用してコントロールプレーンのインストールも管理します。Operator は、OpenShift クラスターで共通アクティビティーを実装し、自動化できるソフトウェアの設定要素です。これはコントローラーとして機能し、クラスター内の必要なオブジェクトの状態 (この場合は Red Hat OpenShift Service Mesh のインストール) を設定または変更できます。

Red Hat OpenShift Service Mesh は以下の Istio アドオンを製品の一部としてバンドルします。

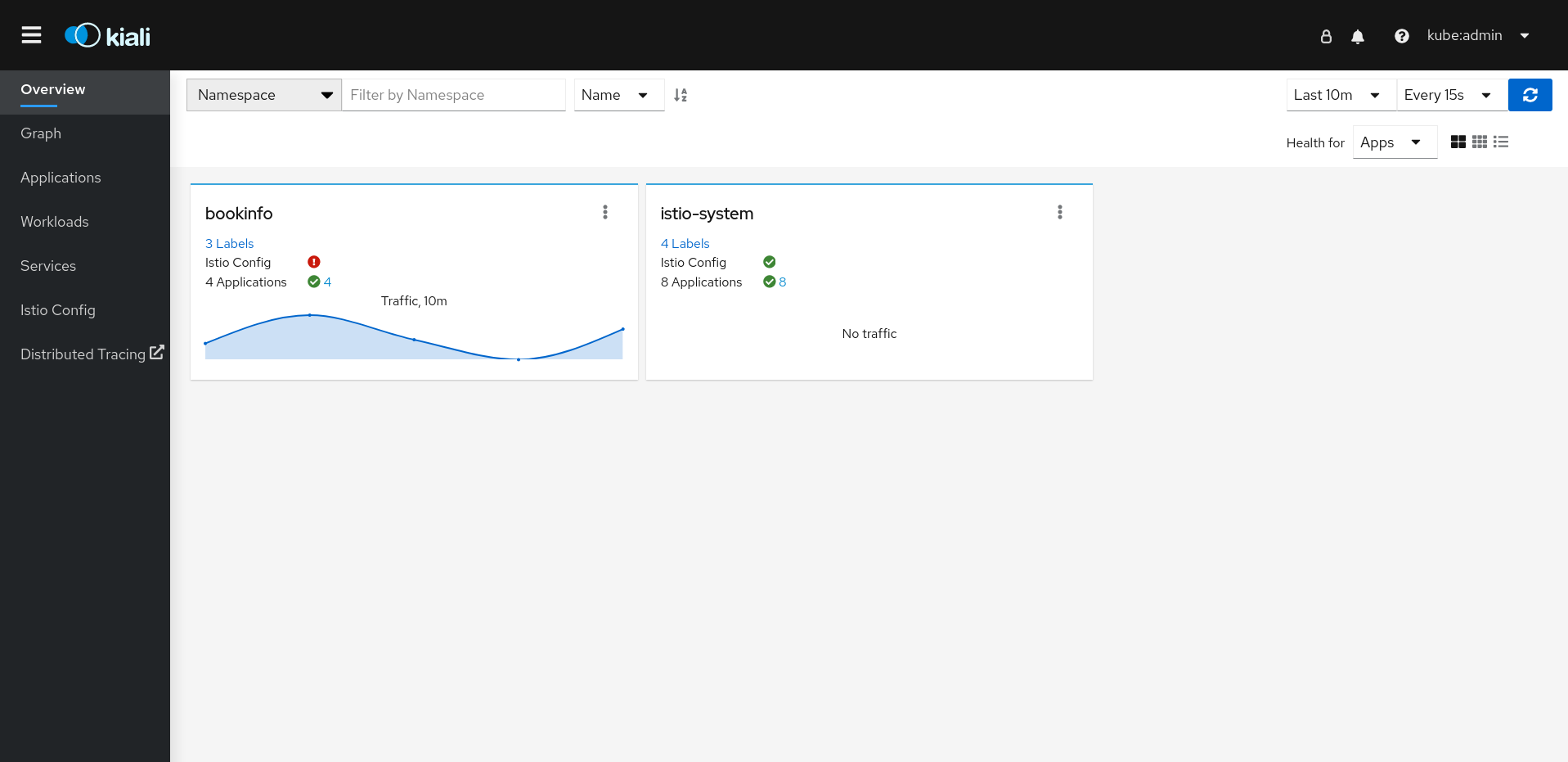

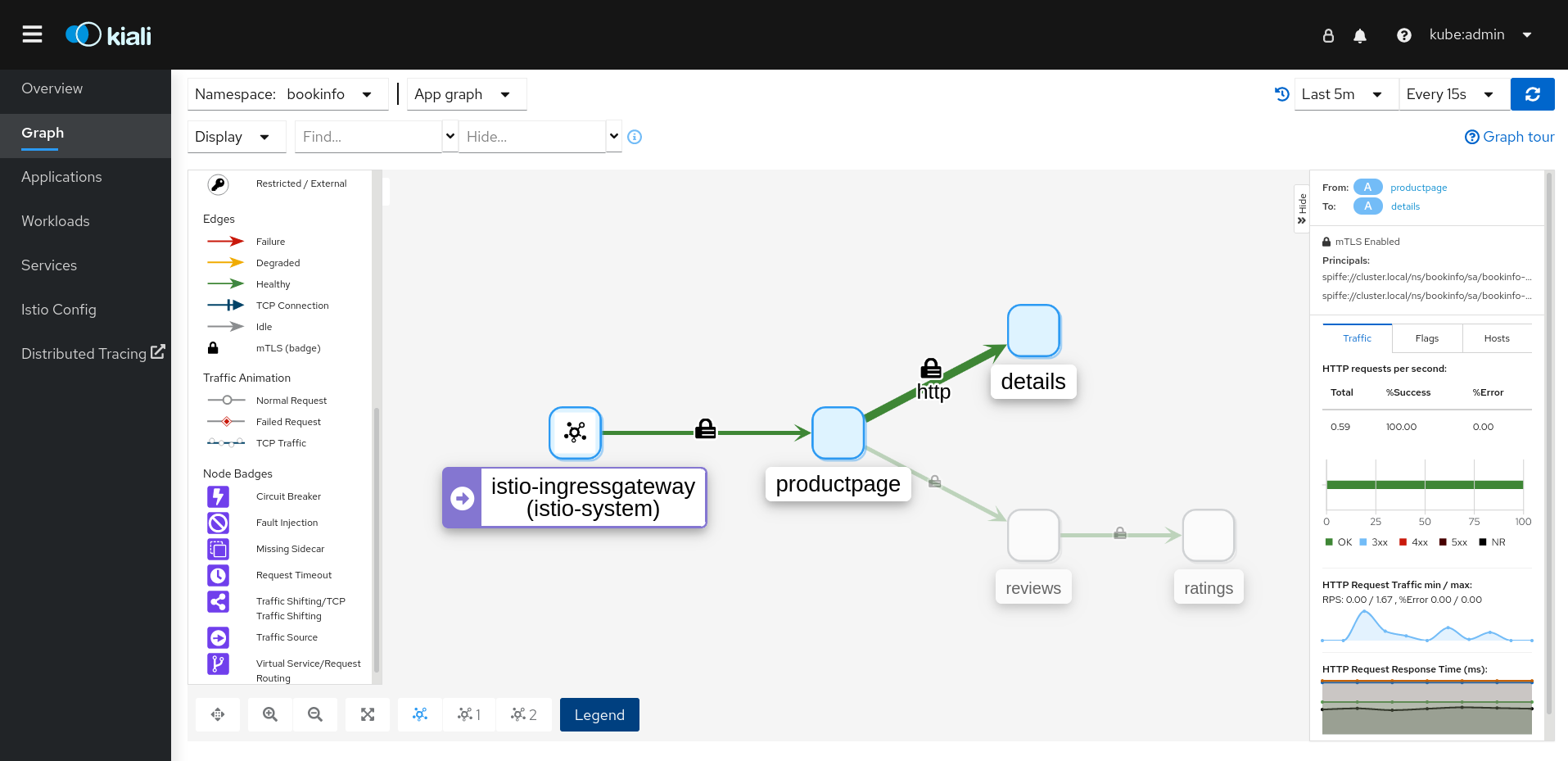

- Kiali: Kiali は Red Hat OpenShift Service Mesh の管理コンソールです。ダッシュボード、可観測性、および堅牢な設定、ならびに検証機能を提供します。これは、トラフィックトポロジーを推測してサービスメッシュの構造を示し、メッシュの正常性を表示します。Kiali は、詳細なメトリクス、強力な検証、Grafana へのアクセス、および分散トレースプラットフォームとの強力な統合を提供します。

- Prometheus: Red Hat OpenShift Service Mesh は Prometheus を使用してサービスからのテレメトリー情報を保存します。Kiali は、メトリクス、ヘルスステータス、およびメッシュトポロジーを取得するために Prometheus に依存します。

- Jaeger: Red Hat OpenShift Service Mesh は分散トレースプラットフォームをサポートします。Jaeger はオープンソースのトレース機能で、複数のサービス間の単一要求に関連付けられたトレースを一元管理し、表示します。分散トレースプラットフォームを使用すると、マイクロサービスベースの分散システムの監視とトラブルシューティングを行うことができます。

- Elasticsearch: Elasticsearch は、オープンソースの分散型 JSON ベースの検索および解析エンジンです。分散トレースプラットフォームは、永続ストレージに Elasticsearch を使用します。

- Grafana: Grafana は、Istio データの高度なクエリーおよびメトリクス分析、ならびにダッシュボードを使用してメッシュ管理者を提供します。任意で、Grafana を使用してサービスメッシュメトリクスを分析できます。

以下の Istio 統合は Red Hat OpenShift Service Mesh でサポートされます。

- 3scale: Istio では、オプションで Red Hat 3scale API Management ソリューションとの統合が提供されます。2.1 より前のバージョンでは、この統合は 3scale Istio アダプターを使用して実行されました。バージョン 2.1 以降では、3scale の統合は WebAssembly モジュールを介して行われます。

3scale アダプターのインストール方法に関する詳細は、3scale Istio アダプターのドキュメント を参照してください。

1.3.3. Kiali について

Kiali は、サービスメッシュのマイクロサービスとそれらの接続方法を表示してサービスメッシュを可視化します。

1.3.3.1. Kiali の概要

Kiali では、OpenShift Container Platform で実行される Service Mesh の可観測性 (Observability) を提供します。Kiali は、Istio サービスメッシュの定義、検証、および確認に役立ちます。トポロジーを推測することでサービスメッシュの構造を理解するのに役立ち、サービスメッシュの健全性に関する情報も提供します。

Kiali は、サーキットブレーカー、要求レート、レイテンシー、トラフィックフローのグラフなどの機能を可視化する、namespace のインタラクティブなグラフビューをリアルタイムで提供します。Kiali では、異なるレベルのコンポーネント (アプリケーションからサービスおよびワークロードまで) に関する洞察を提供し、選択されたグラフノードまたはエッジに関するコンテキスト情報やチャートを含む対話を表示できます。Kiali は、ゲートウェイ、宛先ルール、仮想サービス、メッシュポリシーなど、Istio 設定を検証する機能も提供します。Kiali は詳細なメトリクスを提供し、基本的な Grafana 統合は高度なクエリーに利用できます。Jaeger を Kiali コンソールに統合することで、分散トレースを提供します。

Kiali は、デフォルトで Red Hat OpenShift Service Mesh の一部としてインストールされます。

1.3.3.2. Kiali アーキテクチャー

Kiali はオープンソースの Kiali プロジェクト に基づいています。Kiali は Kiali アプリケーションと Kiali コンソールという 2 つのコンポーネントで設定されます。

- Kiali アプリケーション (バックエンド): このコンポーネントはコンテナーアプリケーションプラットフォームで実行され、サービスメッシュコンポーネントと通信し、データを取得し、処理し、そのデータをコンソールに公開します。Kiali アプリケーションはストレージを必要としません。アプリケーションをクラスターにデプロイする場合、設定は ConfigMap およびシークレットに設定されます。

- Kiali コンソール (フロントエンド): Kiali コンソールは Web アプリケーションです。Kiali アプリケーションは Kiali コンソールを提供し、データをユーザーに表示するためにバックエンドに対してデータのクエリーを実行します。

さらに Kiali は、コンテナーアプリケーションプラットフォームと Istio が提供する外部サービスとコンポーネントに依存します。

- Red Hat Service Mesh (Istio): Istio は Kiali の要件です。Istio はサービスメッシュを提供し、制御するコンポーネントです。Kiali と Istio を個別にインストールすることはできますが、Kiali は Istio に依存し、Istio が存在しない場合は機能しません。Kiali は、Prometheus および Cluster API 経由で公開される Istio データおよび設定を取得する必要があります。

- Prometheus: 専用の Prometheus インスタンスは Red Hat OpenShift Service Mesh インストールの一部として組み込まれています。Istio Telemetry が有効になっている場合、メトリクスデータは Prometheus に保存されます。Kiali はこの Prometheus データを使用して、メッシュトポロジーの判別、メトリクスの表示、健全性の算出、可能性のある問題の表示などを行います。Kiali は Prometheus と直接通信し、Istio Telemetry で使用されるデータスキーマを想定します。Prometheus は Istio に依存しており、Kiali と明示的な依存関係があるため、Kiali の機能の多くは Prometheus なしに機能しません。

- Cluster API: Kiali はサービスメッシュ設定を取得し、解決するために、OpenShift Container Platform (Cluster API) の API を使用します。Kiali は Cluster API に対してクエリーを実行し、たとえば、namespace、サービス、デプロイメント、Pod、その他のエンティティーの定義を取得します。Kiali はクエリーを実行して、異なるクラスターエンティティー間の関係も解決します。Cluster API に対してもクエリーを実行し、仮想サービス、宛先ルール、ルートルール、ゲートウェイ、クォータなどの Istio 設定を取得します。

- Jaeger: Jaeger はオプションですが、Red Hat OpenShift Service Mesh インストールの一部としてデフォルトでインストールされます。デフォルトの Red Hat OpenShift Service Mesh インストールの一部として分散トレースプラットフォームをインストールすると、Kiali コンソールには分散トレースデータを表示するタブが含まれます。Istio の分散トレース機能を無効にした場合、トレースデータは利用できないことに注意してください。また、トレースデータを表示するには、ユーザーは Service Mesh コントロールプレーンがインストールされている namespace にアクセスできる必要があります。

- Grafana: Grafana はオプションですが、デフォルトでは Red Hat OpenShift Service Mesh インストールの一部としてインストールされます。使用可能な場合は、Kiali のメトリクスページに Grafana 内の同じメトリクスにユーザーを移動させるリンクが表示されます。Grafana ダッシュボードへのリンクと Grafana データを表示するには、Service Mesh コントロールプレーンがインストールされている namespace にユーザーがアクセスできる必要があることに注意してください。

1.3.3.3. Kiali の機能

Kiali コンソールは Red Hat Service Mesh に統合され、以下の機能を提供します。

- 健全性: アプリケーション、サービス、またはワークロードの問題を素早く特定します。

- トポロジー: Kiali グラフを使用して、アプリケーション、サービス、またはワークロードの通信方法を可視化します。

- メトリクス: 事前定義済みのメトリクスダッシュボードを使用すると、Go、Node.js、Quarkus、Spring Boot、Thorntail、および Vert.xまた、独自のカスタムダッシュボードを作成することもできます。

- トレース: Jaeger との統合により、アプリケーションを設定するさまざまなマイクロサービスで要求のパスを追跡できます。

- 検証: 最も一般的な Istio オブジェクト (宛先ルール、サービスエントリー、仮想サービスなど) で高度な検証を実行します。

- 設定: ウィザードを使用するか、Kiali コンソールの YAML エディターを直接使用して、Istio ルーティング設定を作成し、更新し、削除できるオプションの機能です。

1.3.4. 分散トレースについて

ユーザーがアプリケーションでアクションを実行するたびに、応答を生成するために多数の異なるサービスに参加を要求する可能性のあるアーキテクチャーによって要求が実行されます。この要求のパスは分散トランザクションです。分散トレースプラットフォームを使用すると、分散トレースを実行できます。これは、アプリケーションを設定するさまざまなマイクロサービスで要求のパスを追跡します。

分散トレースは、さまざまな作業ユニットの情報を連携させるために使用される技術です。これは、分散トランザクションでのイベントのチェーン全体を理解するために、通常さまざまなプロセスまたはホストで実行されます。分散トレースを使用すると、開発者は大規模なサービス指向アーキテクチャーで呼び出しフローを可視化できます。シリアル化、並行処理、およびレイテンシーの原因を理解しておくことも重要です。

分散トレースプラットフォームは、マイクロサービスのスタック全体で個別のリクエストの実行を記録し、トレースとして表示します。トレース とは、システムにおけるデータ/実行パスです。エンドツーエンドトレースは、1 つ以上のスパンで設定されます。

スパンは、オペレーション名、オペレーションの開始時間および期間を持つ、作業の論理単位を表しています。スパンは因果関係をモデル化するためにネスト化され、順序付けられます。

1.3.4.1. 分散トレースの概要

サービスの所有者は、分散トレースを使用してサービスをインストルメント化し、サービスアーキテクチャーに関する洞察を得ることができます。分散トレースを使用して、現代的なクラウドネイティブのマイクロサービスベースのアプリケーションにおける、コンポーネント間の対話の監視、ネットワークプロファイリング、およびトラブルシューティングを行うことができます。

分散トレースを使用すると、以下の機能を実行できます。

- 分散トランザクションの監視

- パフォーマンスとレイテンシーの最適化

- 根本原因分析の実行

Red Hat OpenShift の分散トレースは、2 つの主要コンポーネントで設定されています。

- Red Hat OpenShift 分散トレースプラットフォーム: このコンポーネントは、オープンソースの Jaeger プロジェクト に基づいています。

- Red Hat OpenShift 分散トレースデータ収集: このコンポーネントは、オープンソースの OpenTelemetry プロジェクト に基づいています。

Jaeger は、FIPS 検証済みの暗号化モジュールを使用しません。

1.3.4.2. Red Hat OpenShift 分散トレースのアーキテクチャー

Red Hat OpenShift 分散トレースは、複数のコンポーネントで設定されており、トレースデータを収集し、保存し、表示するためにそれらが連携します。

Red Hat OpenShift 分散トレースプラットフォーム: このコンポーネントは、オープンソースの Jaeger プロジェクト に基づいています。

- クライアント (Jaeger クライアント、Tracer、Reporter、インストルメント化されたアプリケーション、クライアントライブラリー): 分散トレースプラットフォームクライアントは、OpenTracing API の言語固有の実装です。それらは、手動または (Camel (Fuse)、Spring Boot (RHOAR)、MicroProfile (RHOAR/Thorntail)、Wildfly (EAP)、その他 OpenTracing にすでに統合されているものを含む) 各種の既存オープンソースフレームワークを使用して、分散トレース用にアプリケーションをインストルメント化するために使用できます。

- エージェント (Jaeger エージェント、Server Queue、Processor Worker): 分散トレースプラットフォームエージェントは、User Datagram Protocol (UDP) で送信されるスパンをリッスンするネットワークデーモンで、 Collector にバッチ処理や送信を実行します。このエージェントは、インストルメント化されたアプリケーションと同じホストに配置されることが意図されています。これは通常、Kubernetes などのコンテナー環境にサイドカーコンテナーを配置することによって実行されます。

- Jaeger Collector (Collector、Queue、Worker): Jaeger エージェントと同様に、Jaeger Collector はスパンを受信し、これらを処理するために内部キューに配置します。これにより、Jaeger Collector はスパンがストレージに移動するまで待機せずに、クライアント/エージェントにすぐに戻ることができます。

- Storage (Data Store): コレクターには永続ストレージのバックエンドが必要です。Red Hat OpenShift 分散トレースプラットフォームには、スパンストレージ用のプラグ可能なメカニズムがあります。このリリースでは、サポートされているストレージは Elasticsearch のみであることに注意してください。

- Query (Query Service): Query は、ストレージからトレースを取得するサービスです。

- Ingester (Ingester Service): Red Hat OpenShift 分散トレースは Apache Kafka を Collector と実際の Elasticsearch バッキングストレージ間のバッファーとして使用できます。Ingester は、Kafka からデータを読み取り、Elasticsearch ストレージバックエンドに書き込むサービスです。

- Jaeger Console: Red Hat OpenShift 分散トレースプラットフォームユーザーインターフェイスを使用すると、分散トレースデータを可視化できます。検索ページで、トレースを検索し、個別のトレースを設定するスパンの詳細を確認できます。

Red Hat OpenShift 分散トレースデータ収集: このコンポーネントは、オープンソースの OpenTelemetry プロジェクト に基づいています。

- OpenTelemetry Collector: OpenTelemetry Collector は、テレメトリーデータを受信、処理、エクスポートするためのベンダーに依存しない方法です。OpenTelemetry Collector は、Jaeger や Prometheus などのオープンソースの可観測性データ形式をサポートし、1 つ以上のオープンソースまたは商用バックエンドに送信します。Collector は、インストルメンテーションライブラリーがテレメトリーデータをエクスポートするデフォルトの場所です。

1.3.4.3. Red Hat OpenShift 分散トレースの機能

Red Hat OpenShift 分散トレースには、以下の機能が含まれます。

- Kiali との統合: 適切に設定されている場合は、Kiali コンソールから分散トレースデータを表示できます。

- 高いスケーラビリティー: 分散トレースバックエンドは、単一障害点がなく、ビジネスニーズに合わせてスケーリングできるように設計されています。

- 分散コンテキストの伝播: さまざまなコンポーネントからのデータをつなぎ、完全なエンドツーエンドトレースを作成できます。

- Zipkin との後方互換性: Red Hat OpenShift 分散トレースには、Zipkin のドロップイン置き換えで使用できるようにする API がありますが、このリリースでは、Red Hat は Zipkin の互換性をサポートしていません。

1.3.5. 次のステップ

- OpenShift Container Platform 環境に Red Hat OpenShift Service Mesh をインストールする準備 をします。

1.4. サービスメッシュのデプロイメントモデル

Red Hat OpenShift Service Mesh は、さまざまなデプロイメントモデルを複数サポートし、ビジネス要件に最も適合するように、各種方法を組み合わせることができます。

Istio では、テナントはデプロイされたワークロードで共通のアクセスおよび権限を共有するユーザーのグループです。テナントを使用して、異なるチーム間で一定レベルの分離を確保できます。Istio.io またはサービスリソースの NetworkPolicies、AuthorizationPolicies、および exportTo アノテーションを使用して、異なるテナントへのアクセスを分離できます。

1.4.1. クラスター全体 (シングルテナント) メッシュデプロイメントモデル

クラスター全体のデプロイメントには、クラスター全体のリソースを監視する Service Mesh Control Plane が含まれます。クラスター全体のリソースの監視は、コントロールプレーンがすべての名前空間にわたって単一のクエリーを使用して Istio および Kubernetes リソースを監視するという点で、Istio の機能によく似ています。その結果、クラスター全体のデプロイメントにより、API サーバーに送信されるリクエストの数が減少します。

Istio と同様に、クラスター全体のメッシュには、デフォルトで istio-injection=enabled 名前空間ラベルが付いた名前空間が含まれます。このラベルを変更するには、ServiceMeshMemberRoll リソースの spec.labelSelectors フィールドを変更します。

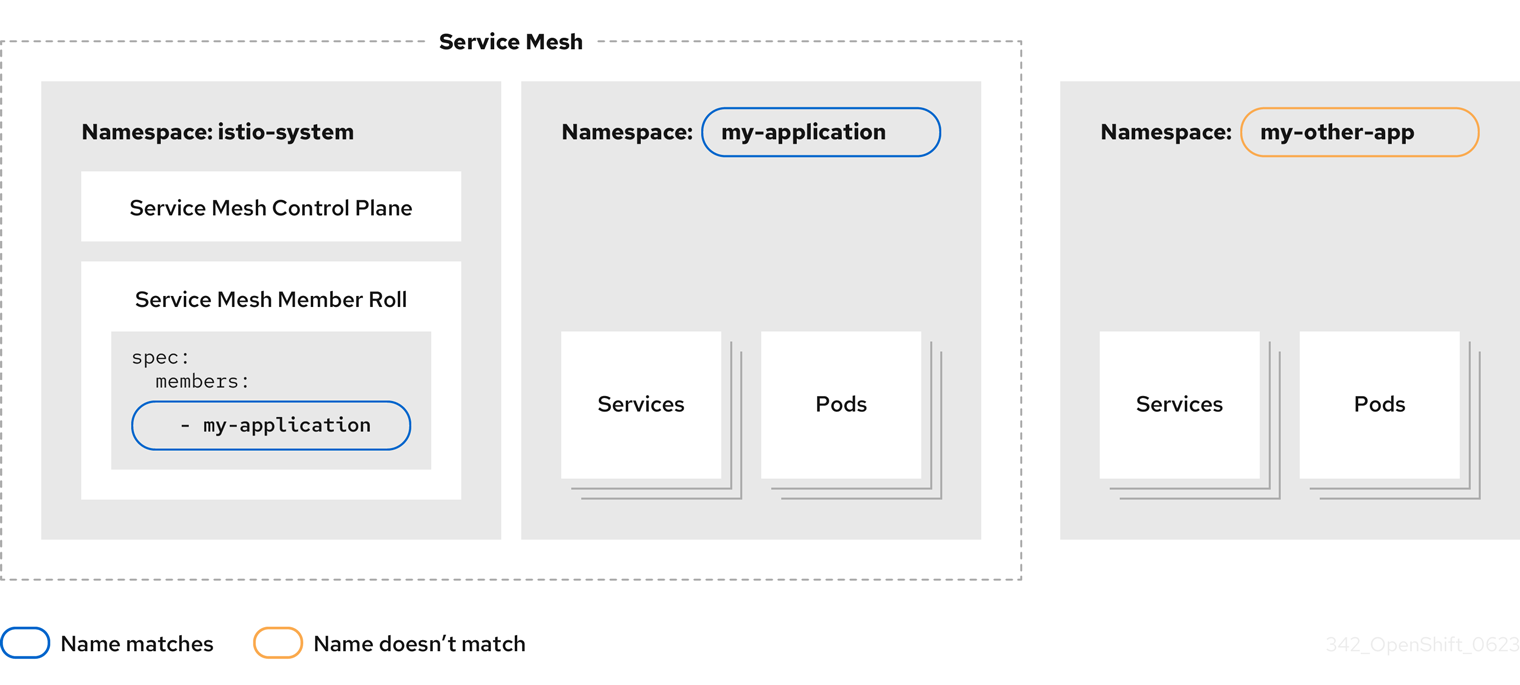

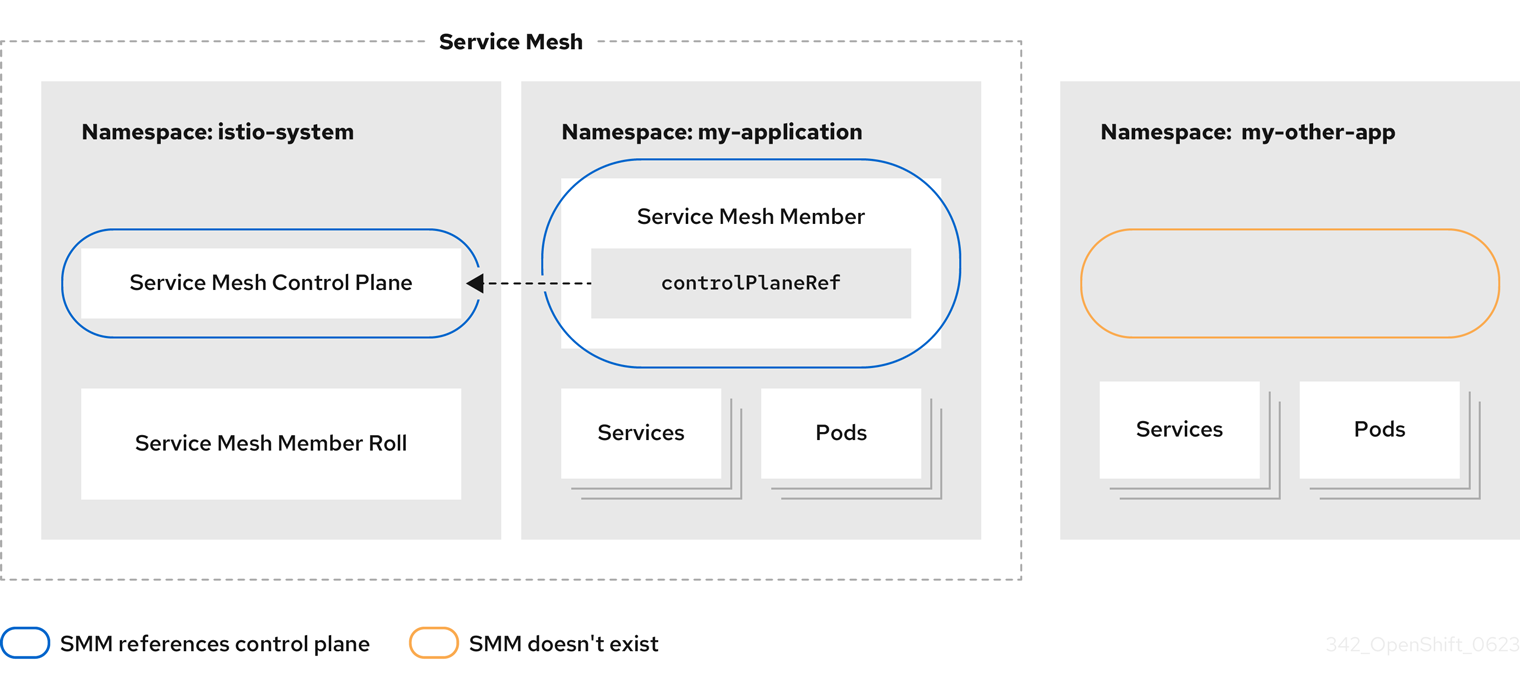

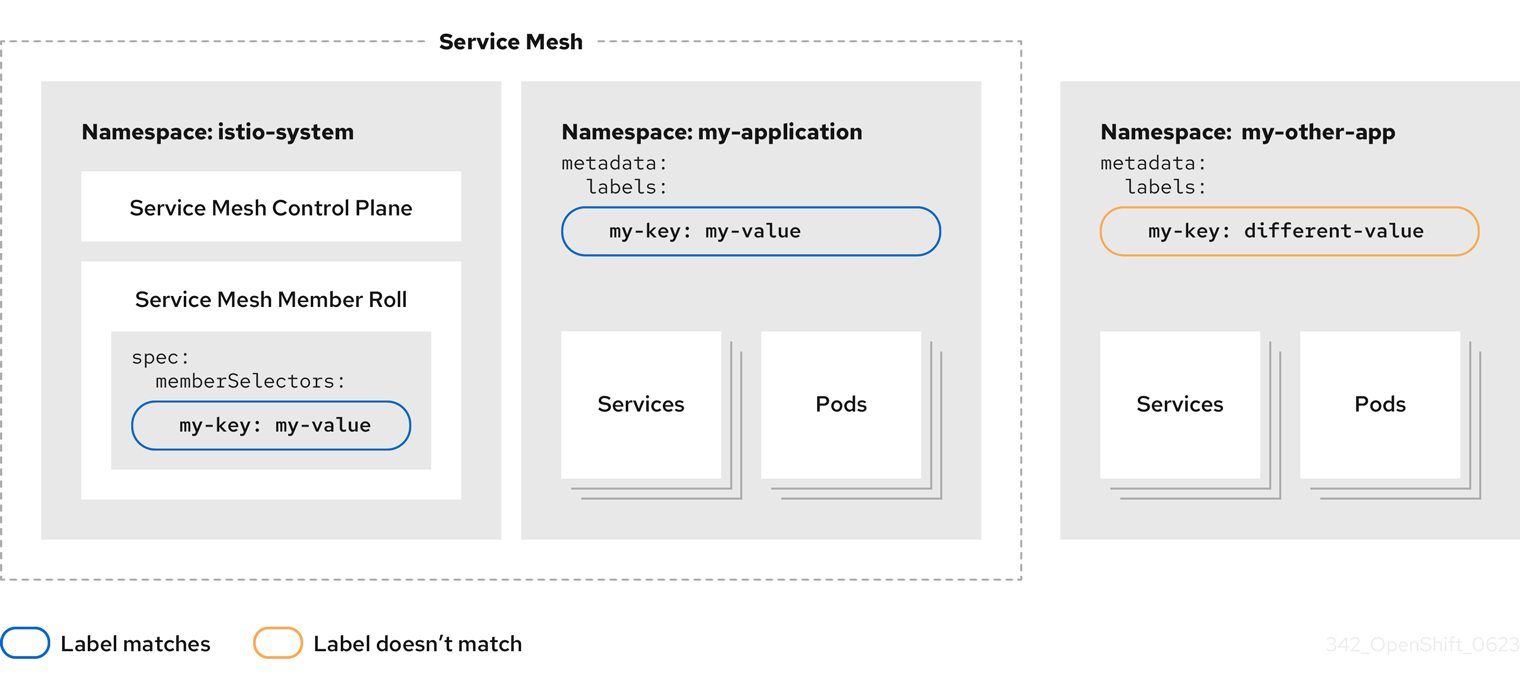

1.4.2. マルチテナントデプロイメントモデル

Red Hat OpenShift Service Mesh は、デフォルトでマルチテナントとして設定される ServiceMeshControlPlane をインストールします。Red Hat OpenShift Service Mesh はマルチテナント Operator を使用して、Service Mesh コントロールプレーンのライフサイクルを管理します。メッシュ内では、テナントに namespace が使用されます。

Red Hat OpenShift Service Mesh は ServiceMeshControlPlane リソースを使用してメッシュインストールを管理します。メッシュのインストールのスコープはデフォルトでは、リソースを含む namespace に限定されます。ServiceMeshMemberRoll および ServiceMeshMember リソースを使用して、別の namespace をメッシュに追加します。Namespace は単一のメッシュにのみ組み込むことができ、複数のメッシュを単一の OpenShift クラスターにインストールできます。

通常のサービスメッシュデプロイメントでは、単一の Service Mesh コントロールプレーンを使用してメッシュ内のサービス間の通信を設定します。Red Hat OpenShift Service Mesh はテナントごとにコントロールプレーン 1 つと、メッシュが 1 つあるソフトマルチテナンシーをサポートします。クラスター内には、複数の独立したコントロールプレーンが存在させることができます。マルチテナントのデプロイメントでは、Service Mesh にアクセスできるプロジェクトを指定し、Service Mesh を他のコントロールプレーンインスタンスから分離します。

クラスター管理者はすべての Istio コントロールプレーンを制御して、表示できますが、テナント管理者は特定の Service Mesh、Kiali、および Jaeger インスタンスしか制御できません。

指定の namespace または namespace 設定だけにワークロードをデプロイするチームパーミッションを付与できます。サービスメッシュ管理者が mesh-user ロールを付与していると、ユーザーは ServiceMeshMember リソースを作成して namespace を ServiceMeshMemberRoll に追加できます。

1.4.3. マルチテーマまたはフェデレーションされたデプロイメントモデル

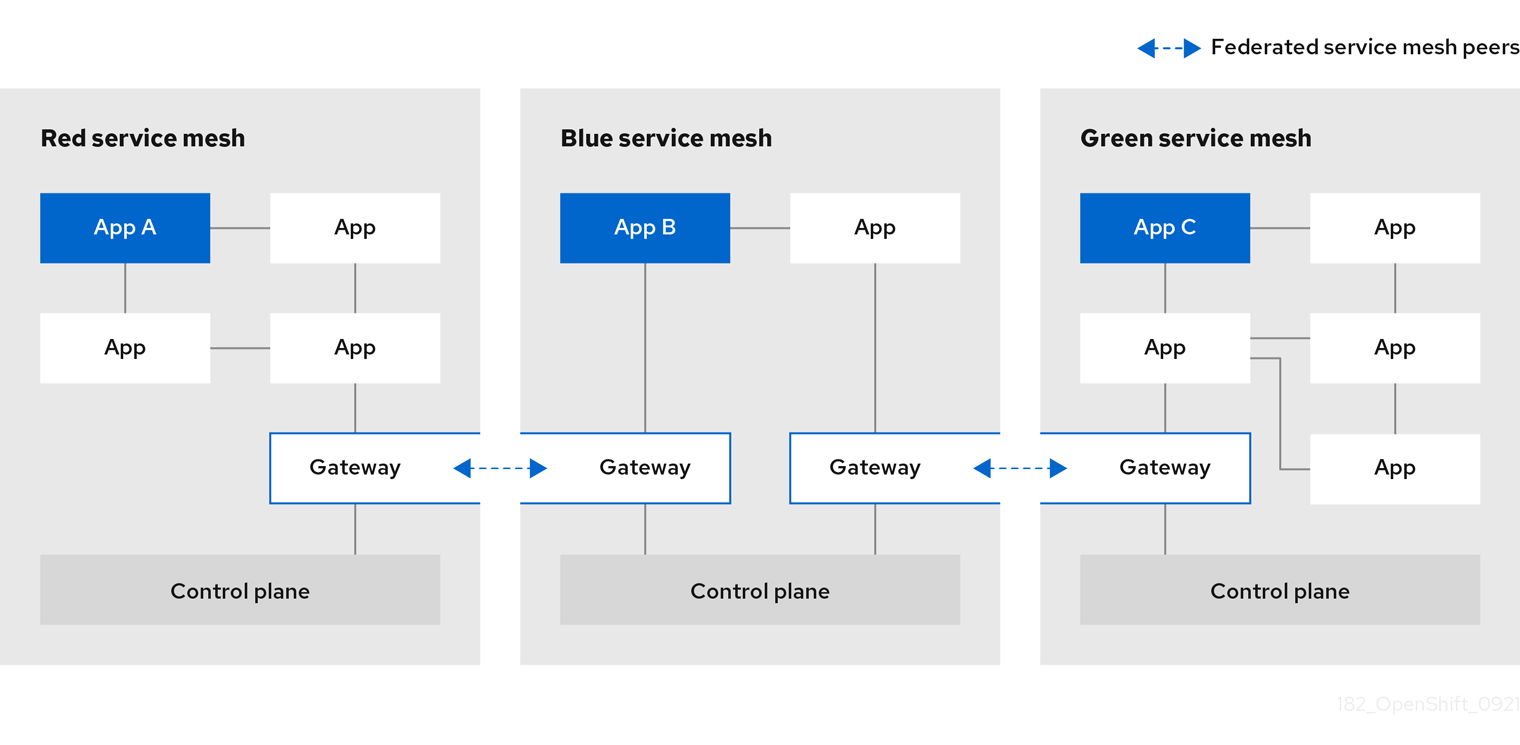

フェデレーション は、個別の管理ドメインで管理される個別のメッシュ間でサービスとワークロードを共有できるデプロイメントモデルです。

Istio マルチクラスターモデルでは、メッシュ間だで高いレベルの信頼が必要なだけでなく、個々のメッシュが存在するすべての Kubernetes API サーバーへのリモートアクセスも必要です。Red Hat OpenShift Service Mesh のフェデレーションは、メッシュ間の最小限の信頼を前提とする Service Mesh のマルチクラスター実装に対して独自のアプローチを採用しています。

フェデレーションされたメッシュ は、単一のメッシュとして動作させるメッシュのグループです。各メッシュのサービスは、独自のサービスにできます。たとえば、別のメッシュからサービスをインポートすることでサービスを追加するメッシュは、メッシュ全体で同じサービスにさらにワークロードを追加し、高可用性を提供することや、その両方を組み合わせることができます。フェデレーションされたメッシュに参加するすべてのメッシュは個別に管理されたままなので、フェデレーション内の他のメッシュとの間でエクスポートやインポートされるサービスを明示的に設定する必要があります。証明書の生成、メトリクス、トレース収集などのサポート機能は、それぞれのメッシュのローカルで機能します。

1.5. Service Mesh と Istio の相違点

Red Hat OpenShift Service Mesh は、追加機能の提供、OpenShift Container Platform へのデプロイ時の差異の処理を実行する Istio のインストールとは異なります。

1.5.1. Istio と Red Hat OpenShift Service Mesh の相違点

以下の機能は Service Mesh と Istio で異なります。

1.5.1.1. コマンドラインツール

Red Hat OpenShift Service Mesh のコマンドラインツールは oc です。 Red Hat OpenShift Service Mesh は、istioctl をサポートしません。

1.5.1.2. インストールおよびアップグレード

Red Hat OpenShift Service Mesh は、Istio インストールプロファイルをサポートしません。

Red Hat OpenShift Service Mesh はサービスメッシュのカナリアアップグレードをサポートしません。

1.5.1.3. 自動的な挿入

アップストリームの Istio コミュニティーインストールは、ラベル付けしたプロジェクト内の Pod にサイドカーコンテナーを自動的に挿入します。

Red Hat OpenShift Service Mesh は、サイドカーコンテナーをあらゆる Pod に自動的に挿入することはなく、プロジェクトにラベルを付けることなくアノテーションを使用して挿入をオプトインする必要があります。この方法で必要となる権限は少なく、ビルダー Pod などの他の OpenShift Container Platform 機能と競合しません。自動挿入を有効にするには、サイドカーの自動挿入 セクションで説明されているとおり、sidecar.istio.io/inject ラベルまたはアノテーションを指定します。

| アップストリーム Istio | Red Hat OpenShift Service Mesh | |

|---|---|---|

| namespace ラベル | "enabled" と "disabled"をサポート | "disabled" をサポート |