3scale のインストール

3scale API Management のインストールおよび設定

概要

はじめに

本ガイドは、3scale のインストールおよび設定に役立ちます。

多様性を受け入れるオープンソースの強化

Red Hat では、コード、ドキュメント、Web プロパティーにおける配慮に欠ける用語の置き換えに取り組んでいます。まずは、マスター (master)、スレーブ (slave)、ブラックリスト (blacklist)、ホワイトリスト (whitelist) の 4 つの用語の置き換えから始めます。この取り組みは膨大な作業を要するため、今後の複数のリリースで段階的に用語の置き換えを実施して参ります。詳細は、CTO である Chris Wright のメッセージ をご覧ください。

第1章 3scale 用レジストリーサービスアカウント

Red Hat 3scale API Management 2.13 との共有環境で registry.redhat.io のコンテナーイメージを使用するには、個々のユーザーの カスタマーポータル の認証情報ではなく、レジストリーサービスアカウント を使用する必要があります。

Operator を介して OpenShift に 3scale をデプロイする前に、この章で説明されている手順に従ってください。デプロイメントではレジストリー認証が使用されるためです。

レジストリーサービスアカウントを作成および変更するには、以下のセクションに概略を示す手順を実施します。

1.1. レジストリーサービスアカウントの作成

レジストリーサービスアカウントを作成するには、以下の手順に従います。

手順

- Registry Service Accounts のページに移動し、ログインします。

- New Service Account をクリックします。

Create a New Registry Service Account のページに表示されるフォームに入力します。

サービスアカウント の名前を追加します。

注記: フォームのフィールドの前に、決められた桁数のランダムに生成された数字の文字列が表示されます。

- Description を入力します。

- Create をクリックします。

- Registry Service Accounts のページに戻ります。

- 作成した サービスアカウント をクリックします。

-

接頭辞の文字列を含めたユーザー名 (例: 12345678|username) およびパスワードを書き留めます。このユーザー名およびパスワードは、

registry.redhat.ioへのログインに使用されます。

Token Information のページには、認証トークンの使用方法を説明したタブがあります。たとえば、Token Information タブには、12345678|username フォーマットのユーザー名およびその下にパスワードの文字列が表示されます。

1.2. コンテナーレジストリー認証の設定

3scale 管理者は、3scale を OpenShift にデプロイする前に、registry.redhat.io との認証を設定します。

前提条件

- 管理者クレデンシャルのある Red Hat OpenShift Container Platform (OCP) アカウント。

-

OpenShift

ocクライアントツールがインストール済みである。詳細は、OpenShift CLI のドキュメント を参照してください。

手順

管理者として OpenShift クラスターにログインします。

oc login -u <admin_username>

$ oc login -u <admin_username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 3scale をデプロイするプロジェクトを開きます。

oc project your-openshift-project

$ oc project your-openshift-projectCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat カスタマーポータルアカウントを使用して

docker-registryシークレットを作成します。threescale-registry-authは作成するシークレットに置き換えます。oc create secret docker-registry threescale-registry-auth \ --docker-server=registry.redhat.io \ --docker-username="customer_portal_username" \ --docker-password="customer_portal_password" \ --docker-email="email_address"

$ oc create secret docker-registry threescale-registry-auth \ --docker-server=registry.redhat.io \ --docker-username="customer_portal_username" \ --docker-password="customer_portal_password" \ --docker-email="email_address"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の出力が表示されるはずです。

secret/threescale-registry-auth created

secret/threescale-registry-auth createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットをサービスアカウントにリンクして、シークレットをイメージをプルするために使用します。サービスアカウント名は、OpenShift Pod が使用する名前と一致する必要があります。以下は、

defaultサービスアカウントを使用する例になります。oc secrets link default threescale-registry-auth --for=pull

$ oc secrets link default threescale-registry-auth --for=pullCopy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットを

builderサービスアカウントにリンクし、ビルドイメージをプッシュおよびプルするためにシークレットを使用します。oc secrets link builder threescale-registry-auth

$ oc secrets link builder threescale-registry-authCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.3. レジストリーサービスアカウントの変更

Registry Service Account ページからサービスアカウントを編集または削除することができます。そのためには、表中の各認証トークン右側のポップアップメニューを使用します。

トークンを再生成したり サービスアカウント を削除したりすると、そのトークンを用いて認証して、registry.redhat.io からコンテンツを取得しているシステムに影響を及ぼします。

各機能の説明は以下のとおりです。

Regenerate Token: 許可されたユーザーは、サービスアカウント に関連付けられたパスワードをリセットすることができます。

注記: サービスアカウント のユーザー名を変更することはできません。

- Update Description: 許可されたユーザーは、サービスアカウント の説明を更新することができます。

- Delete Account: 許可されたユーザーは、サービスアカウント を削除することができます。

1.4. 関連情報

第2章 OpenShift への 3scale のインストール

本セクションでは、OpenShift に Red Hat 3scale API Management 2.13 をデプロイする一連の手順を説明します。

オンプレミスデプロイメントの 3scale ソリューションは、以下の要素で設定されています。

- 2 つの API ゲートウェイ: Embedded APIcast

- 永続ストレージが含まれる 3scale 管理ポータルおよび開発者ポータル 1 つ

- 3scale をデプロイする場合には、まず Red Hat コンテナーレジストリーへのレジストリー認証を設定する必要があります。コンテナーレジストリー認証の設定 を参照してください。

- 3scale Istio アダプターはオプションのアダプターとして利用可能で、これを使用すると、Red Hat OpenShift Service Mesh 内で実行中のサービスにラベルを付け、そのサービスを 3scale と統合することができます。詳細は、3scale アダプター に関するドキュメントを参照してください。

前提条件

- 3scale サーバーは UTC (協定世界時) に設定しておく。

- レジストリーサービスアカウントの作成 の手順を使用して、ユーザークレデンシャルを作成します。

OpenShift に 3scale をインストールするには、以下のセクションに概略を示す手順を実施します。

2.1. OpenShift に 3scale をインストールするためのシステム要件

このセクションでは、OpenShift に 3scale をインストールするためのシステム要件の一覧を紹介します。

2.1.1. 環境要件

Red Hat 3scale API Management には、Red Hat 3scale API Management のサポート対象設定 に指定されている環境が必要です。

永続ボリュームの要件は、デプロイメントの種類によって異なります。外部データベースを使用してデプロイメントする場合、永続ボリュームは必要ありません。一部のデプロイメントタイプでは、Amazon S3 バケットが永続ボリュームの代わりとして機能します。ローカルファイルシステムストレージを使用する場合は、特定のデプロイメントタイプとそれに関連する永続ボリュームの要件を考慮してください。

永続ボリューム

- Redis および MySQL の永続用の 3 つの RWO (ReadWriteOnce) 永続ボリューム

- 開発者ポータルコンテンツおよび System-app Assets 用の 1 つの RWX (ReadWriteMany) 永続ボリューム

RWX 永続ボリュームは、グループによる書き込みができるように設定します。必要なアクセスモードをサポートする永続ボリュームタイプのリストは、OpenShift のドキュメント を参照してください。

ネットワークファイルシステム (NFS) は、RWX ボリュームのみ 3scale でサポートされます。

IBM Power (ppc64le) および IBM Z (s390x) の場合は、以下のコマンドを使用してローカルストレージをプロビジョニングします。

ストレージ

- NFS

コンテンツ管理システム (CMS) ストレージに Amazon Simple Storage Service (Amazon S3) バケットを使用している場合は、以下を実行します。

永続ボリューム

- Redis および MySQL の永続用の 3 つの RWO (ReadWriteOnce) 永続ボリューム

ストレージ

- 1 x Amazon S3 バケット

- NFS

2.1.2. ハードウェア要件

ハードウェア要件は、用途のニーズによって異なります。Red Hat は、テストを行い個々の要件を満たすように環境を設定することを推奨します。OpenShift 上に 3scale の環境を設定する場合、以下が推奨されます。

- クラウド環境へのデプロイメントには、コンピュートタスクに最適化したノードを使用する (AWS c4.2xlarge または Azure Standard_F8)。

- メモリーの要件が現在のノードで使用できる RAM よりも大きい場合、非常に大きなインストールでは、Redis に別のノードが必要になることがある (AWS M4 シリーズまたは Azure Av2 シリーズ)。

- ルーティングタスクとコンピュートタスクには別のノードを使用する。

- 3scale 固有のタスクには専用のコンピュートノードを使用する。

関連情報

2.2. OpenShift への 3scale operator のインストール

3scale は、直近 2 つの OpenShift Container Platform (OCP) 一般提供 (GA) リリースをサポートします。詳細は、Red Hat 3scale API Management のサポート対象構成 のアーティクル記事を参照してください。

本セクションでは、以下の項目の実施方法について説明します。

- 新しいプロジェクトを作成する。

- Red Hat 3scale API Management インスタンスをデプロイする。

- Operator Lifecycle Manager (OLM) を使用して 3scale operator をインストールする。

- operator をデプロイした後にカスタムリソースをデプロイする。

前提条件

管理者権限を持つアカウントを使用して、サポート対象バージョンの OpenShift Container Platform 4 クラスターにアクセスできる。

- サポート対象設定の情報は、Red Hat 3scale API Management のサポート対象構成 を参照してください。

3scale operator とカスタムリソース定義 (CRD) は、新たに作成した空の プロジェクト にデプロイしてください。インフラストラクチャーが含まれる既存のプロジェクトにデプロイすると、既存の要素が変更または削除されることがあります。

OpenShift に 3scale operator をインストールするには、以下のセクションに概略を示す手順を実施します。

2.2.1. 新しい OpenShift プロジェクトの作成

以下の手順で、3scale-project という新しい OpenShift プロジェクトを作成する方法について説明します。このプロジェクト名を実際のプロジェクト名に置き換えてください。

手順

新しい OpenShift プロジェクトを作成するには、以下の手順を実施します。

英数字とダッシュを使用して、有効な名前を指定します。たとえば、以下のコマンドを実行して

3scale-projectを作成します。oc new-project 3scale-project

$ oc new-project 3scale-projectCopy to Clipboard Copied! Toggle word wrap Toggle overflow

これにより、operator、APIManager カスタムリソース (CR)、および Capabilities カスタムリソースがインストールされる新しい OpenShift プロジェクト が作成されます。operator は、そのプロジェクトの OLM を通じてカスタムリソースを管理します。

2.2.2. OLM を使用した 3scale operator のインストールと設定

Operator Lifecycle Manager (OLM) を使用して、OpenShift Container Platform (OCP) 4.6 クラスターに 3scale operator をインストールします。この際に、OCP コンソールの OperatorHub を使用します。以下のインストールモードを使用して、3scale operator をインストールできます。

- クラスター全体。Operator がクラスターのすべての namespace で利用できます。

- クラスター上の特定の namespace。

ネットワークが制限された環境または非接続クラスターで OpenShift Container Platform を使用している場合には、Operator Lifecycle Manager は OperatorHub を使用できなくなります。OLM の設定および使用については、Operator のネットワークが制限された環境での Operator Lifecycle Manager の使用 に記載の手順に従ってください。

前提条件

- 新しい OpenShift プロジェクトの作成 で定義したプロジェクトに 3scale operator をインストールおよびデプロイしている。

手順

OpenShift Container Platform コンソールにおいて、管理者権限を持つアカウントを使用してログインします。

注記メニュー構造は、使用している OpenShift のバージョンによって異なります。

- Operators > OperatorHub の順にクリックします。

- Filter by keyword ボックスに 3scale operator と入力して、Red Hat Integration - 3scale を検索します。

- Red Hat Integration - 3scale をクリックします。Operator に関する情報が表示されます。

- operator に関する情報を確認し、Install をクリックします。Install Operator ページが開きます。

- Install Operator ページで、任意のチャネルを選択して、Update channel セクションを更新します。

Installation mode セクションで、Operator のインストール先を選択します。

- All namespaces on the cluster(default): Operator はクラスターのすべての namespace で利用可能になります。

- A specific namespace on the cluster: operator は、選択したクラスター上の特定の単一 namespace でしか使用することができません。

- Install をクリックします。

- インストールが完了すると、Operator が使用できる状態になったことを示す確認メッセージが表示されます。

3scale Operator の ClusterServiceVersion (CSV) が正しくインストールされていることを確認します。また、Operator のインストールが成功したことが報告されているかどうかも確認します。

- Operators > Installed Operators の順にクリックします。

- Red Hat Integration - 3scale Operator をクリックします。

- Details タブで、Conditions セクションまで下にスクロールします。Succeeded 条件のReason 列の下に InstallSucceeded と表示されます。

ネットワークが制限された環境で OCP を使用する場合、ここに示す手順に加えて、3scale 開発者ポータルで使用する許可されるドメインのリストを作成します。以下の例を参照してください。

- 開発者ポータルに追加するすべてのリンク

- GitHub などのサードパーティー SSO プロバイダーを使用した SSO インテグレーション

- 請求

- 外部 URL をトリガーする Webhook

2.2.2.1. ネットワーク接続が得られない環境における制約

ネットワーク接続が得られない環境の 3scale 2.13 に対する現在の制約の概要を、以下のリストに示します。

- 開発者ポータルへの GitHub ログインができない

- サポートのリンクが機能しない

- 外部ドキュメントへのリンクが機能しない

- 開発者ポータルの OpenAPI Specification (OAS) 検証ツールが機能しない (これにより、外部サービスへのリンクが影響を受けます)

ActiveDocs の製品 Overview ページにおいて、OAS へのリンクが機能しない

- 新たな ActiveDocs 仕様を作成する場合、オプション Skip swagger validations を選択する必要もあります。

関連情報

- トラブルシューティングに関する情報は、OpenShift Container Platform のドキュメント を参照してください。

- ネットワークが制限された環境での OLM の使用に関する詳細は、Operator のネットワークが制限された環境での Operator Lifecycle Manager の使用 を参照してください。

- 制限されたネットワークでのインストールの準備について詳しくは、切断されたインストール用のイメージのミラーリング を参照してください。

- サポート対象設定の情報は、Red Hat 3scale API Management のサポート対象構成 を参照してください。

2.2.3. OLM を使用した 3scale operator のアップグレード

Operator ベースのデプロイメントで、1 つの namespace から全 namespace のクラスター全体のインストールに、3scale Operator をアップグレードするには、その namespace から 3scale Operator を削除してから、クラスター上にその Operator を再インストールする必要があります。

クラスター管理者は Web コンソールを使用して、選択した namespace からインストールされた Operator を削除できます。Operator をアンインストールしても、既存の 3scale インスタンスはアンインストールされません。

3scale Operator を namespace からアンインストールしたら、OLM を使用してクラスター全体のモードで Operator をインストールできます。

前提条件

- namespace の削除パーミッションがある 3scale 管理者権限または OpenShift ロール。

手順

OpenShift Container Platform コンソールにおいて、管理者権限を持つアカウントを使用してログインします。

注記メニュー構造は、使用している OpenShift のバージョンによって異なります。

- Operators > OperatorHub の順にクリックします。インストール済みの Operator ページが表示されます。

- 3scale を Filter by name に入力して Operator を見つけ、クリックします。

- Operator Details ページで、Actions ドロップダウンメニューから Uninstall Operator を選択して、特定の namespace から削除します。

Uninstall Operator? ダイアログボックスが表示され、以下が通知されます。

Removing the operator will not remove any of its custom resource definitions or managed resources. If your operator has deployed applications on the cluster or configured off-cluster resources, these will continue to run and need to be cleaned up manually. This action removes the operator as well as the Operator deployments and pods, if any. Any operands and resources managed by the operator, including CRDs and CRs, are not removed. The web console enables dashboards and navigation items for some operators. To remove these after uninstalling the operator, you might need to manually delete the operator CRDs.

Removing the operator will not remove any of its custom resource definitions or managed resources. If your operator has deployed applications on the cluster or configured off-cluster resources, these will continue to run and need to be cleaned up manually. This action removes the operator as well as the Operator deployments and pods, if any. Any operands and resources managed by the operator, including CRDs and CRs, are not removed. The web console enables dashboards and navigation items for some operators. To remove these after uninstalling the operator, you might need to manually delete the operator CRDs.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Uninstall を選択します。この Operator は実行を停止し、更新を受信しなくなります。

- OpenShift Container Platform コンソールで、Operators > OperatorHub をクリックします。

- Filter by keyword ボックスに 3scale operator と入力して、Red Hat Integration - 3scale を検索します。

- Red Hat Integration - 3scale をクリックします。Operator に関する情報が表示されます。

- Install をクリックします。Install Operator ページが開きます。

- Install Operator ページで、任意のチャネルを選択して、Update channel セクションを更新します。

- Installation mode セクションで、All namespaces on the cluster(default) を選択します。Operator はクラスターのすべての namespace で利用可能になります。

- Subscribe をクリックします。3scale operator の詳細ページが表示され、Subscription Overview を確認できます。

- サブスクリプションの Upgrade Status が Up to date と表示されていることを確認します。

- 3scale operator の ClusterServiceVersion (CSV) が表示されることを確認します。

関連情報

- 3scale operator のインストールに関する詳細は、3scale API Management のインストールおよび設定 を参照してください。

2.2.3.1. マイクロリリースの自動アプリケーションの設定

自動更新を取得するには、3scale operator の承認ストラテジーが Automatic に設定されている必要があります。これにより、マイクロリリースの更新を自動的に適用できます。ここでは、Automatic と Manual の設定の違いを説明し、もう 1 つから別の設定に変更する手順を説明します。

自動および手動:

- インストール時に、デフォルトで Automatic 設定が選択されたオプションになります。新規更新のインストールは、更新が利用可能になると行われます。これは、インストール時または後にいつでも変更できます。

- インストール時に 手動 オプションを選択するか、その後のいつでも手動オプションを選択すると、更新が利用可能になった時点で受信されます。次に、インストール計画 を承認し、独自に適用する必要があります。

手順

- Operators > Installed Operators の順にクリックします。

- Installed Operators のリストから 3scale API Management をクリックします。

- Subscription タブをクリックします。Subscription Details の見出しの下に、小見出しの Approval が表示されます。

- Approval の下のリンクをクリックします。リンクはデフォルトで Automatic に設定されます。小見出しのモーダル (Change Update Approval Strategy) が表示されます。

- 選択するオプション Automatic (デフォルト) または Manual を選択し、Save をクリックします。

関連情報

- ネームスペースへの Operator のインストール の 承認ストラテジー を参照してください。

2.3. APIcast operator の OpenShift へのインストール

本セクションでは、OpenShift Container Platform (OCP) コンソールから APIcast operator をインストールする手順について説明します。

前提条件

- OCP 4.x 以降およびその管理者権限。

手順

-

Projects > Create Project の順に移動し、新規プロジェクト

operator-testを作成します。 - Operators > OperatorHub の順にクリックします。

- Filter by keyword ボックスに apicast operator と入力して Red Hat Integration - 3scale APIcast gateway を検索します。

- Red Hat Integration - 3scale APIcast gateway をクリックします。APIcast operator に関する情報が表示されます。

- Install をクリックします。Create Operator Subscription ページが表示されます。

Install をクリックして、Create Operator Subscription ページのデフォルトの選択をすべて受け入れます。

注記クラスター全体または namespace 固有のオプションなど、さまざまな Operator のバージョンとインストールモードを選択できます。クラスター全体のインストールは、クラスターごとに 1 つだけ行うことができます。

- サブスクリプションのアップグレードステータスが Up to date と表示されます。

-

Operators > Installed Operators の順にクリックし、

operator-testプロジェクトで APIcast operator の ClusterServiceVersion (CSV) ステータスが最終的に InstallSucceeded と表示されることを確認します。

2.4. operator を使用した 3scale のデプロイ

このセクションでは、APIManager CR を使用して、3scale operator 経由で 3scale ソリューションをインストールおよびデプロイする方法を説明します。

ワイルドカードルートは、3scale 2.6 以降 廃止されています。

- この機能は、バックグラウンドで Zync により処理されます。

- API プロバイダーが作成、更新、または削除されると、これらの変更が自動的にルートに反映されます。

前提条件

- コンテナーレジストリー認証の設定

- 3scale operator で自動承認機能を有効にして 3scale のマイクロリリースの自動更新が確実に受信されるようにする。Automatic はデフォルトの承認設定です。これを特定のニーズに合わせて変更するには、マイクロリリースの自動アプリケーションの設定 の手順を使用します。

- 先に OpenShift への 3scale operator のインストール の記載の手順に従って Operator を使用して 3scale をデプロイする。

OpenShift Container Platform 4

- OpenShift クラスターの管理者権限を持つユーザーアカウント。

- サポート対象設定の情報は、Red Hat 3scale API Management のサポート対象構成 を参照してください。

以下の手順に従って、operator を使用して 3scale をデプロイします。

2.4.1. APIManager カスタムリソースのデプロイ

Amazon Simple Storage Service (Amazon S3) を使用する場合は、Amazon Simple Storage Service 3scale FileStorage のインストール を参照してください。

Operator は APIManager CR を監視し、APIManager CR で指定されているために必要な 3Scale ソリューションをデプロイします。

手順

Operators > Installed Operators の順にクリックします。

- Installed Operators のリストで、Red Hat Integration - 3scale をクリックします。

- API Manager タブをクリックします。

- Create APIManager をクリックします。

サンプルのコンテンツを消去して以下の YAML 定義をエディターに追加し、続いて Create をクリックします。

3scale 2.8 より前のバージョンでは、

highAvailabilityフィールドをtrueに設定してレプリカの自動追加を設定できるようになりました。3scale 2.8 以降、レプリカの追加は以下の例のように APIManager CR の replicas フィールドによって制御されます。注記wildcardDomain パラメーターの値は、OpenShift Container Platform (OCP) ルーターのアドレスに解決される有効なドメイン名である必要があります。たとえば、

apps.mycluster.example.comになります。最小要件のある APIManager CR:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow レプリカが設定された APIManager CR:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.2. 管理ポータルの URL の取得

operator を使用して 3scale をデプロイすると、固定 URL (3scale-admin.${wildcardDomain}) のデフォルトテナントが作成されます。

3scale の Dashboard には、テナントの新しいポータル URL が表示されます。たとえば、<wildCardDomain> が 3scale-project.example.com の場合、管理ポータル URL は https://3scale-admin.3scale-project.example.com となります。

wildcardDomain は、インストール中に指定した <wildCardDomain> パラメーターです。以下のコマンドを使用し、ブラウザーでこの一意の URL を開きます。

xdg-open https://3scale-admin.3scale-project.example.com

xdg-open https://3scale-admin.3scale-project.example.com

オプションとして、マスターポータル URL (master.${wildcardDomain}) に新しいテナントを作成できます。

2.4.3. APIManager 管理ポータルとマスター管理ポータルの認証情報を取得する

Operator ベースのデプロイ後に 3scale 管理ポータルまたはマスター管理ポータルのいずれかにログインするには、個別のポータルごとに認証情報が必要です。これらの認証情報を取得するには:

次のコマンドを実行して、管理ポータルの認証情報を取得します。

oc get secret system-seed -o json | jq -r .data.ADMIN_USER | base64 -d oc get secret system-seed -o json | jq -r .data.ADMIN_PASSWORD | base64 -d

oc get secret system-seed -o json | jq -r .data.ADMIN_USER | base64 -d oc get secret system-seed -o json | jq -r .data.ADMIN_PASSWORD | base64 -dCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Admin Portal 管理者としてログインして、これらの認証情報が機能していることを確認します。

次のコマンドを実行して、マスター管理ポータルの認証情報を取得します。

oc get secret system-seed -o json | jq -r .data.MASTER_USER | base64 -d oc get secret system-seed -o json | jq -r .data.MASTER_PASSWORD | base64 -d

oc get secret system-seed -o json | jq -r .data.MASTER_USER | base64 -d oc get secret system-seed -o json | jq -r .data.MASTER_PASSWORD | base64 -dCopy to Clipboard Copied! Toggle word wrap Toggle overflow - マスター管理ポータル管理者としてログインして、これらの認証情報が機能していることを確認します。

関連情報

APIManager フィールドに関する詳細は、参考のドキュメント を参照してください。

2.4.4. Operator を使用した 3scale の外部データベース

Red Hat 3scale API Management デプロイメントからデータベースを外部化すると、アプリケーションからの分離とデータベースレベルでのサービス中断に対する回復力が提供されることになります。サービス中断に対する復元力は、データベースをホストするインフラストラクチャーまたはプラットフォームプロバイダーが提供するサービスレベルアグリーメント (SLA) によって異なります。これは 3scale では提供されていません。選択したデプロイメントによって提供されるデータベースの外部化の詳細は、関連ドキュメントを参照してください。

Operator を使用して 3scale の外部データベースを使用する場合、その目的は、たとえば 1 つ以上のデータベースに障害が発生した場合でも、中断のない稼働時間を提供することです。

3scale Operator ベースのデプロイメントで外部データベースを使用する場合は、次の点に注意してください。

- 3scale の重要なデータベースを外部に設定し、デプロイします。重要なデータベースには、システムデータベース、システム redis およびバックエンド redis コンポーネントが含まれます。これらのコンポーネントが高可用性となるようにデプロイおよび設定するようにしてください。

3scale をデプロイする前に対応する Kubernetes シークレットを作成して、3scale のこれらのコンポーネントへの接続エンドポイントを指定します。

- 詳細は、外部データベースモードでのインストール を参照してください。

- データベース以外のデプロイメント設定についての詳細は、Enabling Pod Disruption Budgets を参照してください。

APIManager CR で、

.spec.externalComponents属性を設定して、システムデータベース、システム redis およびバックエンド redis が外部であることを指定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

さらに zync データベースを高可用性にして、再起動時のキュージョブデータを失う可能性をなくす場合は、以下の点に注意してください。

- zync データベースを外部でデプロイおよび設定します。このデータベースを高可用性の設定でデプロイおよび設定するようにしてください。

3scale をデプロイする前に対応する Kubernetes シークレットを作成して、3scale の zync データベースへの接続エンドポイントを指定します。

- Zync データベースシークレット を参照してください。

-

3scale を設定するには、

APIManagerCR の.spec.externalComponents.zync.database属性をtrueに設定し、zync データベースが外部データベースであることを指定します。

2.5. operator を使用した OpenShift への 3scale のデプロイメント設定オプション

本セクションでは、operator を使用した OpenShift への Red Hat 3scale API Management のデプロイメント設定オプションについて説明します。

前提条件

- コンテナーレジストリー認証の設定

- 先に OpenShift への 3scale operator のインストール の記載の手順に従って Operator を使用して 3scale をデプロイする。

OpenShift Container Platform 4.x

- OpenShift クラスターの管理者権限を持つユーザーアカウント。

2.5.1. Embedded APIcast のプロキシーパラメーターの設定

3scale の管理者は、Embedded APIcast ステージングおよび実稼働環境用のプロキシーパラメーターを設定することができます。このセクションでは、APIManager カスタムリソース (CR) でプロキシーパラメーターを指定するための参照情報を提供します。つまり、3scale operator (APIManager CR) を使用して 3scale を OpenShift にデプロイします。

これらのパラメーターは、APIManager CR を初めてデプロイするときに指定できます。または、デプロイされた APIManager CR を更新すると、Operator が更新を調整します。APIManager カスタムリソースのデプロイ を参照してください。

Embedded APIcast には、プロキシー関連の 4 つの設定パラメーターがあります。

-

allProxy -

httpProxy -

httpsProxy -

noProxy

allProxy

allProxyパラメーターは、要求でプロトコル固有のプロキシーが指定されていない場合にサービスに接続するために使用される HTTP または HTTPS プロキシーを指定します。

プロキシーを設定したら、allProxy パラメーターをプロキシーのアドレスに設定して APIcast を設定します。プロキシーでは認証機能はサポートされていません。つまり、APIcast では認証された要求はプロキシーには送信されません。

allProxy パラメーターの値は文字列で、デフォルトはなく、パラメーターは必須ではありません。この形式を使用して、spec.apicast.productionSpec.allProxy パラメーターまたは spec.apicast.stagingSpec.allProxy パラメーターを設定します。

<scheme>://<host>:<port>

以下に例を示します。

httpProxy

httpProxy パラメーターは、HTTP サービスへの接続に使用される HTTP プロキシーを指定します。

プロキシーを設定したら、httpProxy パラメーターをプロキシーのアドレスに設定して APIcast を設定します。プロキシーでは認証機能はサポートされていません。つまり、APIcast では認証された要求はプロキシーには送信されません。

httpProxy パラメーターの値は文字列で、デフォルトはなく、パラメーターは必須ではありません。この形式を使用して、spec.apicast.productionSpec.httpProxy パラメーターまたは spec.apicast.stagingSpec.httpProxy パラメーターを設定します。

http://<host>:<port>

以下に例を示します。

httpsProxy

httpsProxy パラメーターは、サービスへの接続に使用される HTTPS プロキシーを指定します。

プロキシーを設定したら、httpsProxy パラメーターをプロキシーのアドレスに設定して APIcast を設定します。プロキシーでは認証機能はサポートされていません。つまり、APIcast では認証された要求はプロキシーには送信されません。

httpsProxy パラメーターの値は文字列で、デフォルトはなく、パラメーターは必須ではありません。この形式を使用して、spec.apicast.productionSpec.httpsProxy パラメーターまたは spec.apicast.stagingSpec.httpsProxy パラメーターを設定します。

https://<host>:<port>

以下に例を示します。

noProxy

noProxy パラメーターは、ホスト名とドメイン名のコンマ区切りリストを指定します。要求にこれらの名前のいずれかが含まれる場合、APIcast は要求をプロキシーしません。

たとえば、メンテナンス操作中にプロキシーへのアクセスを停止する必要がある場合は、noProxy パラメーターをアスタリスク (*) に設定します。これは、すべての要求で指定されたすべてのホストに一致し、プロキシーを実質的に無効にします。

noProxy パラメーターの値は文字列で、デフォルトはなく、パラメーターは必須ではありません。spec.apicast.productionSpec.noProxy パラメーターまたは spec.apicast.stagingSpec.noProxy パラメーターを設定するには、コンマ区切りの文字列を指定します。以下に例を示します。

2.5.2. 3scale Operator を使用したカスタム環境の注入

Embedded APIcast を使用する 3scale インストールでは、3scale Operator を使用してカスタム環境を注入できます。Embedded APIcast は、Managed APIcast または Hosted APIcast とも呼ばれます。カスタム環境は、ゲートウェイが提供するすべてのアップストリーム API に APIcast が適用する動作を定義します。カスタム環境を作成するには、Lua コードでグローバル設定を定義します。

3scale のインストールの前または後にカスタム環境を注入できます。カスタム環境を注入した後、および 3scale をインストールした後、カスタム環境を削除できます。3scale Operator は変更を調整します。

前提条件

- 3scale Operator がインストールされている。

手順

注入するカスタム環境を定義する Lua コードを記述します。たとえば、次の

env1.luaファイルは、3scale Operator がすべてのサービスに対してロードするカスタムログポリシーを示しています。Copy to Clipboard Copied! Toggle word wrap Toggle overflow カスタム環境を定義する Lua ファイルからシークレットを作成します。以下に例を示します。

oc create secret generic custom-env-1 --from-file=./env1.lua

$ oc create secret generic custom-env-1 --from-file=./env1.luaCopy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットには複数のカスタム環境を含めることができます。カスタム環境を定義する各ファイルの

'-from-fileオプションを指定します。Operator は各カスタム環境をロードします。作成したシークレットを参照する APIManager カスタムリソース (CR) を定義します。以下の例は、カスタム環境を定義するシークレットの参照に関連するコンテンツのみを示しています。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow APIManager CR は、カスタム環境を定義する複数のシークレットを参照できます。Operator は各カスタム環境をロードします。

カスタム環境を追加する APIManager CR を作成します。以下に例を示します。

oc apply -f apimanager.yaml

$ oc apply -f apimanager.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

次のステップ

カスタム環境を定義するシークレットのコンテンツを更新することはできません。カスタム環境を更新する必要がある場合は、以下のいずれかを実行できます。

-

推奨されるオプションは、別の名前でシークレットを作成し、APIManager (CR) フィールドの

customEnvironments[].secretRef.nameを更新することです。Operator はローリング更新をトリガーし、更新されたカスタム環境をロードします。 -

あるいは、

spec.apicast.productionSpec.replicasまたはspec.apicast.stagingSpec.replicasを 0 に設定して既存のシークレットを更新してから、spec.apicast.productionSpec.replicasまたはspec.apicast.stagingSpec.replicasを以前の値に設定して APIcast をも再デプロイし直します。

2.5.3. 3scale operator によるカスタムポリシーの注入

Embedded APIcast を使用する 3scale インストールでは、3scale operator を使用してカスタムポリシーを注入できます。Embedded APIcast は、Managed APIcast または Hosted APIcast とも呼ばれます。カスタムポリシーを注入すると、ポリシーコードが APIcast に追加されます。次に、以下のいずれかを使用して、カスタムポリシーを API 製品のポリシーチェーンに追加できます。

- 3scale API

-

Productカスタムリソース (CR)

3scale 管理ポータルを使用してカスタムポリシーを製品のポリシーチェーンに追加するには、カスタムポリシーのスキーマを CustomPolicyDefinition CR に登録する必要もあります。カスタムポリシー登録は、管理ポータルを使用して製品のポリシーチェーンを設定する場合にのみ必要です。

3scale インストールの一部として、またはインストール後にカスタムポリシーを挿入できます。カスタムポリシーを注入し、3scale をインストールした後、APIManager CR から指定内容を削除することにより、カスタムポリシーを削除できます。3scale Operator は変更を調整します。

前提条件

- 3scale operator をインストールしているか、以前にインストールしている。

-

Write your own policy で説明されているように、カスタムポリシーを定義している。つまり、カスタムポリシーを定義する

my-policy.lua、apicast-policy.json、およびinit.luaファイルなどをすでに作成している。

手順

1 つのカスタムポリシーを定義するファイルからシークレットを作成します。以下に例を示します。

oc create secret generic my-first-custom-policy-secret \ --from-file=./apicast-policy.json \ --from-file=./init.lua \ --from-file=./my-first-custom-policy.lua

$ oc create secret generic my-first-custom-policy-secret \ --from-file=./apicast-policy.json \ --from-file=./init.lua \ --from-file=./my-first-custom-policy.luaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 複数のカスタムポリシーがある場合は、カスタムポリシーごとにシークレットを作成します。シークレットには、カスタムポリシーを 1 つだけ含めることができます。

カスタムポリシーが含まれる各シークレットを参照する APIManager CR を定義します。APIcast ステージングと APIcast 実稼働環境に同じシークレットを指定できます。次の例は、カスタムポリシーを含む参照シークレットに関連するコンテンツのみを示しています。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow APIManager CR は、異なるカスタムポリシーを定義する複数のシークレットを参照できます。Operator は各カスタムポリシーをロードします。

カスタムポリシーが含まれるシークレットを参照する APIManager CR を作成します。以下に例を示します。

oc apply -f apimanager.yaml

$ oc apply -f apimanager.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

次のステップ

カスタムポリシーを定義するシークレットのコンテンツを更新することはできません。カスタムポリシーを更新する必要がある場合は、次のいずれかを実行できます。

-

推奨されるオプションは、別の名前でシークレットを作成し、APIManager CR

customPoliciesセクションを更新して、新しいシークレットを参照することです。Operator はローリング更新をトリガーし、更新されたカスタムポリシーをロードします。 -

あるいは、

spec.apicast.productionSpec.replicasまたはspec.apicast.stagingSpec.replicasを 0 に設定して既存のシークレットを更新してから、spec.apicast.productionSpec.replicasまたはspec.apicast.stagingSpec.replicasを以前の値に設定して APIcast をも再デプロイし直します。

2.5.4. 3scale operator を使用した OpenTracing の設定

Embedded APIcast を使用する 3scale インストールでは、3scale operator を使用して OpenTracing を設定できます。OpenTracing は、ステージング環境または実稼働環境用または両方の環境で設定することができます。OpenTracing を有効にすると、APIcast インスタンスに関してより多くの洞察を得て、可観測性を向上できます。

前提条件

- 3scale operator がインストールされているか、インストール中である。

- OpenTracing を使用するための APIcast の設定 に記載の前提条件。

- Jaeger がインストールされている。

手順

stringData.configに OpenTracing 設定の詳細を含めて、シークレットを定義します。これは、OpenTracing 設定の詳細が含まれる属性の唯一有効な値です。その他の仕様では、APIcast が OpenTracing 設定の詳細を受け取れないようにします。以下の例は、有効なシークレット定義を示しています。Copy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットを作成します。たとえば、以前のシークレット定義を

myjaeger.yamlファイルに保存した場合は、以下のコマンドを実行します。oc create -f myjaeger.yaml

$ oc create -f myjaeger.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenTracing属性を指定する APIManager カスタムリソース (CR) を定義します。CR 定義で、openTracing.tracingConfigSecretRef.name属性を OpenTracing 設定の詳細が含まれるシークレットの名前に設定します。以下の例は、OpenTracing の設定に関するコンテンツのみを示しています。Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenTracing を設定する APIManager CR を作成します。たとえば、APIManager CR を

apimanager1.yamlファイルに保存した場合は、以下のコマンドを実行します。oc apply -f apimanager1.yaml

$ oc apply -f apimanager1.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

次のステップ

OpenTracing のインストール方法に応じて、Jaeger サービスユーザーインターフェイスでトレースが表示されるはずです。

2.5.5. 3scale operator を使用した Pod レベルでの TLS の有効化

3scale では、実稼働環境用とステージング環境用の 2 つの APIcast インスタンスをデプロイします。TLS は、実稼働用またはステージングのみ、または両方のインスタンスに対して有効にできます。

前提条件

- TLS を有効にするための有効な証明書がある。

手順

以下のように、有効な証明書からシークレットを作成します。

oc create secret tls mycertsecret --cert=server.crt --key=server.key

$ oc create secret tls mycertsecret --cert=server.crt --key=server.keyCopy to Clipboard Copied! Toggle word wrap Toggle overflow この設定により、APIManager カスタムリソース (CR) 内のシークレット参照が公開されます。シークレットを作成してから、以下のように APIManager CR でシークレットの名前を参照します。

-

実稼働: APIManager CR は

.spec.apicast.productionSpec.httpsCertificateSecretRefフィールドの証明書を公開します。 ステージング: APIManager CR は

.spec.apicast.stagingSpec.httpsCertificateSecretRefフィールドの証明書を公開します。必要に応じて、以下を設定できます。

-

httpsPortは、APIcast が HTTPS 接続に対してリッスンを開始するポートを示します。これが HTTP ポートと競合する場合には、APIcast はこのポートを HTTPS にのみ使用します。 httpsVerifyDepthは、クライアント証明書チェーンの最大長を定義します。注記APIManager CR から有効な証明書および参照を指定します。設定で

httpsPortにアクセスでき、httpsCertificateSecretRefではない場合、APIcast は組み込まれた自己署名証明書を使用します。これは、推奨されません。

-

実稼働: APIManager CR は

- Operators > Installed Operators の順にクリックします。

- Installed Operators のリストで、3scale Operator をクリックします。

- API Manager タブをクリックします。

- Create APIManager をクリックします。

以下の YAML 定義をエディターに追加します。

production で有効にする場合は、以下の YAML 定義を設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow staging で有効にする場合は、以下の YAML 定義を設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- Create をクリックします。

2.5.6. 評価用デプロイメントの概念実証

以降のセクションで、3scale の評価用デプロイメントの概念実証に適用される設定オプションを説明します。このデプロイメントでは、デフォルトとして内部データベースが使用されます。

外部データベースの設定は、実稼働環境向けの標準デプロイメントオプションです。

2.5.6.1. デフォルトのデプロイメント設定

コンテナーには、Kubernetes によるリソースの制限およびリクエスト が適用されます。

- これにより、最低限のパフォーマンスレベルが確保されます。

- また、外部サービスおよびソリューションの割り当てを可能にするために、リソースを制限します。

- 内部データベースのデプロイメント

ファイルストレージは、永続ボリューム (PV) がベースになります。

- ボリュームの 1 つには、読み取り、書き込み、実行 (RWX) アクセスモードが必要です。

- OpenShift は、リクエストに応じてこれらを提供するように設定されている必要があります。

- MySQL を内部リレーショナルデータベースとしてデプロイします。

デフォルトの設定オプションは、お客様による概念実証 (PoC) または評価用途に適しています。

1 つ、複数、またはすべてのデフォルト設定オプションを、APIManager CR の特定フィールドの値でオーバーライドすることができます。3scale 演算子では、利用可能なすべての組み合わせが可能です。

2.5.6.2. 評価モードでのインストール

評価モードでのインストールの場合、コンテナーには Kubernetes によるリソースの制限およびリクエスト が適用されません。以下に例を示します。

- メモリーのフットプリントが小さい。

- 起動が高速である。

- ノートパソコンで実行可能である。

- プリセールス/セールスでのデモに適する。

関連情報

- 詳細は、APIManager CR を参照してください。

2.5.7. 外部データベースモードでのインストール

Red Hat 3scale API Management デプロイメントからデータベースを外部化すると、アプリケーションからの分離とデータベースレベルでのサービス中断に対する回復力が提供されることになります。サービス中断に対する復元力は、データベースをホストするインフラストラクチャーまたはプラットフォームプロバイダーが提供するサービスレベルアグリーメント (SLA) によって異なります。これは 3scale では提供されていません。選択したデプロイメントによって提供されるデータベースの外部化の詳細は、関連ドキュメントを参照してください。

外部データベースのインストールは、中断のない稼働時間を提供したい場合、または独自のデータベースを再利用する予定がある運用環境に適しています。

3scale の外部データベースインストールモードを有効にすると、以下のデータベースの 1 つまたな複数を 3scale の外部として設定できます。

-

backend-redis -

system-redis -

system-database(mysql、postgresql、またはoracle) -

zync-database

3scale をデプロイするために APIManager CR を作成する前に、OpenShift シークレットを使用して以下に示す外部データベースの接続設定を提供する必要があります。

2.5.7.1. バックエンド Redis シークレット

2 つの外部 Redis インスタンスをデプロイし、以下の例に示すように接続設定を入力します。

シークレット 名は backend-redis にする必要があります。

2.5.7.2. システム Redis シークレット

2 つの外部 Redis インスタンスをデプロイし、以下の例に示すように接続設定を入力します。

シークレット 名は system-redis にする必要があります。

2.5.7.3. システムデータベースシークレット

-

シークレット 名は

system-databaseにする必要があります。

3scale をデプロイする場合には、システムデータベースに 3 つの代替手段があります。代替手段に関連のシークレットごとに、異なる属性と値を設定します。

- MySQL

- PostgreSQL

- Oracle データベース

MySQL、PostgreSQL、または Oracle Database のシステムデータベースシークレットをデプロイするには、以下の例のように接続設定を入力します。

MySQL システムデータベースシークレット

3scale 2.12 で MySQL 8.0 を使用する場合は、認証プラグインを mysql_native_password に設定する必要があります。MySQL 設定ファイルに以下を追加します。

[mysqld] default_authentication_plugin=mysql_native_password

[mysqld]

default_authentication_plugin=mysql_native_passwordPostgreSQL システムデータベースシークレット

Oracle システムデータベースシークレット

-

{DB_USER}および{DB_PASSWORD}は、通常の非システムユーザーのユーザー名およびパスワードです。 -

{DB_NAME}は Oracle Database の サービス名 です。 -

ORACLE_SYSTEM_PASSWORDはオプションです。データベースユーザーの設定 を参照してください。

2.5.7.4. Zync データベースシークレット

zync データベースの設定では、spec.externalComponents.zync.database フィールドが true に設定されている場合、3scale をデプロイする前に zync という名前のシークレットを作成する必要があります。このシークレットでは、DATABASE_URL および DATABASE_PASSWORD フィールドを外部の zync データベースを参照する値に設定します。以下に例を示します。

zync データベースは高可用性モードである必要があります。

2.5.7.5. 3scale をデプロイするための APIManager カスタムリソース

-

外部コンポーネントを有効にする場合は、3scale をデプロイする前に、外部コンポーネント (

backend-redis、system-redis、system-database、zync) ごとにシークレットを作成する必要があります。 -

外部の

system-databaseの場合は、外部化するデータベースのタイプを 1 つだけ選択します。

APIManager カスタムリソース (CR) の設定は、選択したデータベースが 3scale デプロイメントの外部にあるかどうかによって異なります。

backend-redis、system-redis、または system-database が 3scale の外部にある場合は、次の例に示すように APIManager CR externalComponents オブジェクトを設定します。

2.5.8. 3scale operator での Pod アフィニティーの有効化

すべてのコンポーネントの 3scale operator で Pod アフィニティーを有効にすることができます。これにより、各 deploymentConfig からの Pod レプリカがクラスターの異なるノードに確実に分散され、異なるアベイラビリティーゾーン (AZ) 間で均等に分散されるようになります。

2.5.8.1. コンポーネントレベルでのノードのアフィニティーおよび容認のカスタマイズ

APIManager CR 属性を使用して、3scale ソリューションの Kubernetes の アフィニティー と 容認 をカスタマイズします。これを行うと、さまざまな 3scale コンポーネントを Kubernetes ノードにスケジュールするようにカスタマイズできます。

たとえば、backend-listener のカスタムノードアフィニティーと system-memcached のカスタム容認を設定するには、次の手順を実行します。

カスタムのアフィニティーと容認

次のアフィニティーブロックを apicastProductionSpec またはデータベース以外の deploymentConfig に追加します。これにより、preferredDuringSchedulingIgnoredDuringExecution を使用したソフト podAntiAffinity 設定が追加されます。スケジューラーは、この apicast-production Pod のセットを、異なる AZ の別々のホストで実行しようとします。それが不可能な場合は、別の場所で実行できるようにします。

ソフト podAntiAffinity

次の例では、requiredDuringSchedulingIgnoredDuringExecution を使用してハード podAntiAffinity 設定を指定します。Pod をノードにスケジュールするには、条件が満たされる必要があります。空きリソースが少ないクラスターでは、新しい Pod をスケジュールできなくなるなどのリスクが存在します。

ハード podAntiAffinity

関連情報

アフィニティーおよび容認に関連する属性の完全リストは、APIManager CDR を参照してください。

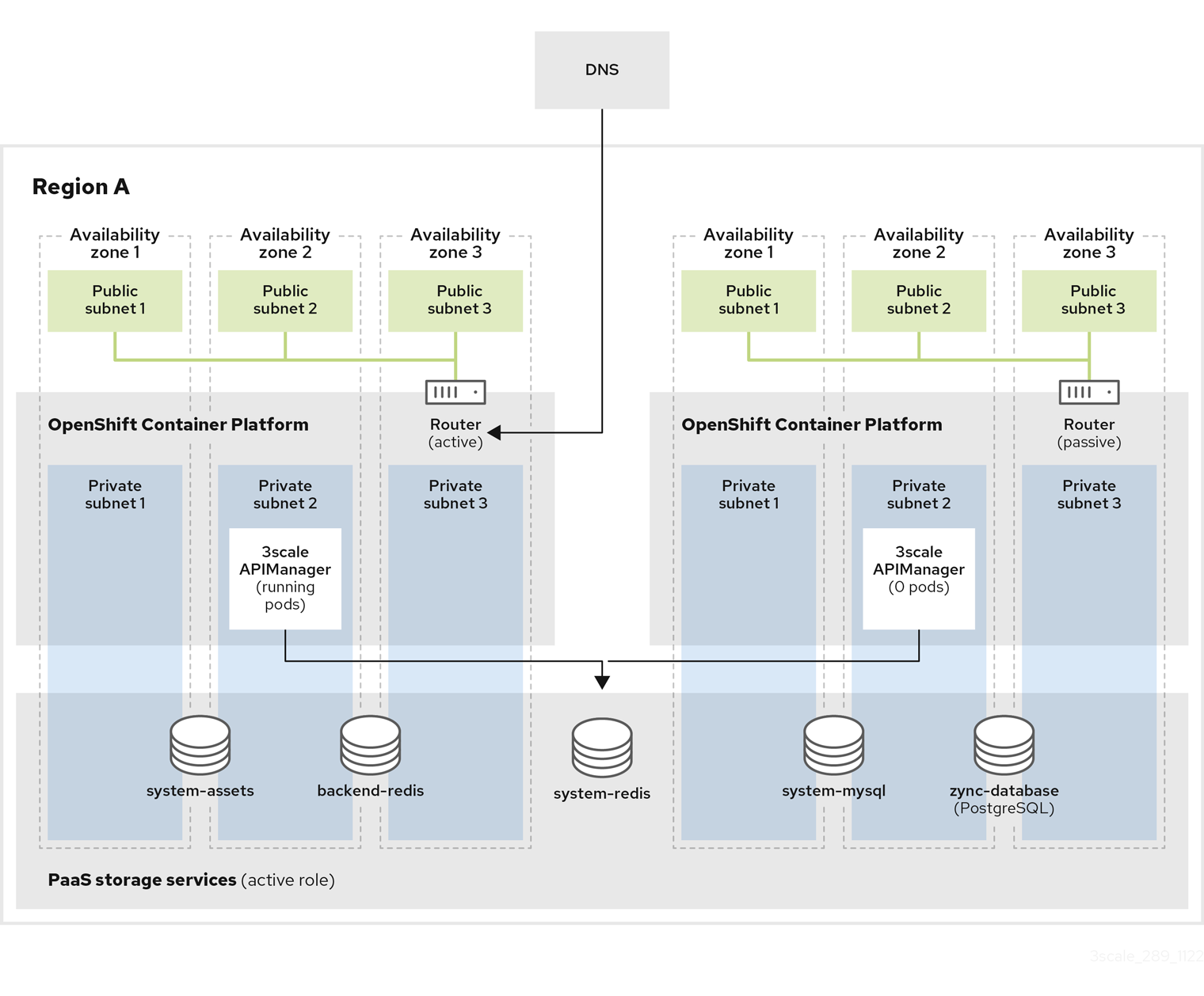

2.5.9. 複数のアベイラビリティーゾーン内の複数のクラスター

障害が発生した場合、パッシブクラスターをアクティブモードにすると、手順が完了するまでサービスのプロビジョニングが中断されます。このサービス中断が生じるため、メンテナンス期間を設けるようにしてください。

このドキュメントでは、Amazon Web Services (AWS) を使用したデプロイメントに焦点を当てています。他のパブリッククラウドベンダーにも、同じ設定オプションが適用されます。このようなプロバイダーのマネージドデータベースサービスでは、複数のアベイラビリティーゾーンや複数のリージョンがサポートされてします。

3scale を複数の OpenShift クラスターおよび高可用性 (HA) ゾーンにインストールする場合は、ここで紹介するオプションを利用できます。

複数クラスターのインストールオプションでは、クラスターはアクティブ/パッシブ設定で動作し、フェイルオーバー手順にいくつかの手動手順が含まれます。

2.5.9.1. 複数クラスターのインストールの前提条件

複数の OpenShift クラスターを使用する 3scale インストールでは、以下を使用します。

-

APIManager カスタムリソース (CR) の

kubernetes.io/hostnameルールとtopology.kubernetes.io/zoneルールの両方で Pod アフィニティーを使用します。 - APIManager CR で Pod の Disruption Budget を使用します。

- 複数のクラスターにわたる 3scale インストールでは、APIManager CR で、同じ共有の wildcardDomain 属性仕様を使用する必要があります。データベースに保存されている情報が競合するため、このインストールモードではクラスターごとに異なるドメインを使用することはできません。

トークンやパスワードなどの認証情報を含むシークレットを、同じ値を使用してすべてのクラスターに手動でデプロイする必要があります。3scale operator は、クラスターごとにセキュアなランダム値を使用してシークレットを作成します。この場合、両方のクラスターで同じ認証情報が必要です。シークレットのリストとその設定方法は、3scale operator のドキュメントに記載されています。以下は、両方のクラスターでミラーリングする必要があるシークレットのリストです。

-

backend-internal-api -

system-app -

system-events-hook -

system-master-apicast system-seedbackend-redis、system-redis、system-database、およびzyncのデータベース接続文字列を使用してシークレットを手動でデプロイする必要があります。外部データベースモードでのインストール を参照してください。- クラスター間で共有されるデータベースは、すべてのクラスターで同じ値を使用する必要があります。

- 各クラスターに独自のデータベースがある場合は、クラスターごとに異なる値を使用する必要があります。

-

2.5.9.5. 同期データベースを使用した異なるリージョン上のアクティブ/パッシブクラスター

このセットアップでは、異なるリージョンに 2 つ以上のクラスターを配置し、アクティブ/パッシブモードで 3scale をデプロイします。1 つのクラスターはアクティブでトラフィックを受信します。他のクラスターはスタンバイモードでトラフィックを受信しないためパッシブですが、アクティブクラスターに障害が発生した際にアクティブロールを引き受けることができるよう準備されています。

適切なデータベースアクセスレイテンシーを実現するために、各クラスターに独自のデータベースインスタンスがあります。アクティブな 3scale インストールのデータベースが 3scale パッシブインストールの読み取りレプリカデータベースにレプリケートされるため、すべてのリージョンでデータが利用可能で最新の状態になり、フェイルオーバーが可能になります。

2.5.9.6. 同期データベースの設定とインストール

手順

- 異なるアベイラビリティーゾーンを使用して、異なるリージョンに 2 つ以上の OpenShift クラスターを作成します。3 つ以上のゾーンを使用することを推奨します。

すべてのリージョンで Amazon RDS Multi-AZ を有効にして、必要なすべての AWS ElastiCache インスタンスを作成します。

- Backend Redis データベース用の AWS EC を 2 つ: リージョンごとに 1 つ。

- System Redis データベース用の AWS EC を 2 つ: リージョンごとに 1 つ。

- グローバルデータストア機能を有効にしてクロスリージョンレプリケーションを使用します。これにより、パッシブリージョンのデータベースがアクティブリージョンのマスターデータベースからの読み取りレプリカになります。

すべてのリージョンで Amazon RDS Multi-AZ を有効にして、必要なすべての AWS RDS インスタンスを作成します。

- System データベース用の AWS RDS を 2 つ。

- Zync データベース用の AWS RDS を 2 つ

- クロスリージョンレプリケーションを使用します。これにより、パッシブリージョンのデータベースがアクティブリージョンのマスターデータベースからの読み取りレプリカになります。

- クロスリージョンレプリケーションを使用して、各リージョンのシステムアセット用の AWS S3 バケットを設定します。

- AWS Route53 またはお使いの DNS プロバイダーでカスタムドメインを作成し、アクティブなクラスターの OpenShift ルーターを参照するようにします。これは、APIManager CR の wildcardDomain 属性と一致する必要があります。

3scale をパッシブクラスターにインストールします。APIManager CR は、前のステップで使用したものと同一である必要があります。すべての Pod が実行されたら、すべての

backend、system、zync、およびAPIcastPod に 0 個のレプリカをデプロイするように APIManager を変更します。- アクティブなデータベースからのジョブの消費を避けるために、レプリカを 0 に設定します。最初に各レプリカが 0 に設定されていると、Pod の依存関係によりデプロイメントが失敗します。たとえば、Pod は他の Pod が実行されているかどうかを確認します。まず通常どおりにデプロイしてから、レプリカを 0 に設定します。

2.5.9.7. 同期データベースの手動フェイルオーバー

手順

共有データベースの手動フェイルオーバー の手順 1、2、および 3 を実行します。

- すべてのクラスターに、独自の独立したデータベース、つまりアクティブリージョンのマスターからの読み取りレプリカがあります。

- すべてのデータベースでフェイルオーバーを手動で実行して、パッシブリージョンで新しいマスターを選択する必要があります。選択すると、そのマスターがアクティブリージョンになります。

実行する必要があるデータベースの手動フェイルオーバーは次のとおりです。

- AWS RDS: System と Zync。

- AWS ElastiCaches: Backend と System。

- 共有データベースの手動フェイルオーバー の手順 4 を実行します。

2.5.10. Amazon Simple Storage Service 3scale fileStorage のインストール

3scale をデプロイするための APIManager カスタムリソース (CR) を作成する前に、OpenShift シークレットを使用して Amazon Simple Storage Service (Amazon S3) サービスの接続設定を提供します。

- ローカルファイルシステムストレージで 3scale をデプロイする場合は、このセクションを飛ばして次に進んでください。

- シークレットに選択する名前は、既存のシークレット名ではなく、APIManager CR で参照される限り、任意の名前にすることができます。

-

S3 互換ストレージに

AWS_REGION が提供されていない場合は、defaultを使用してください。そうしないと、デプロイメントが失敗します。 - 免責事項: ここに記載されている外部 Web サイトへのリンクは、お客様の利便性のみを目的として提供されています。Red Hat はリンクの内容を確認しておらず、コンテンツまたは可用性について責任を負わないものとします。外部 Web サイトへのリンクが含まれていても、Red Hat が Web サイトまたはその組織、製品、もしくはサービスを保証することを意味するものではありません。お客様は、外部サイトまたはコンテンツの使用 (または信頼) によって生じる損失または費用について、Red Hat が責任を負わないことに同意するものとします。

2.5.10.1. Amazon S3 バケットの作成

前提条件

- Amazon Web Services (AWS) アカウントを作成している。

手順

- システム資産を保存するためのバケットを作成します。

- 開発者ポータルのロゴ機能を使用する場合は、S3 のパブリックアクセスブロッカーを無効にします。

以下の最低限のパーミッションで Identity and Access Management (IAM) ポリシーを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のルールで CORS 設定を作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.10.2. OpenShift シークレットの作成

以下の例は、永続ボリューム要求 (PVC) の代わりに Amazon S3 を使用する 3scale fileStorage を示しています。

AWS S3 互換プロバイダーは、AWS_HOSTNAME、AWS_PATH_STYLE、および AWS_PROTOCOL オプションキーを使用して S3 シークレットで設定できます。詳細は、fileStorage S3 認証情報のシークレットフィールド の表を参照してください。

以下の例では、任意の シークレット 名を指定することができます。シークレット名が APIManager CR で参照されるためです。

最後に、3scale をデプロイするための APIManager CR を作成します。

APIManager SystemS3Spec を確認してください。

次の表は、Identity and Access Management (IAM) および Security Token Service (STS) 設定の fileStorage Amazon S3 認証情報シークレットフィールドの要件を示しています。

- Secure Token Service (STS) を使用する S3 認証方法は、権限が制限された短期間のセキュリティー認証情報で使用します。

- S3 Identity and Access Management (IAM) は、長期的な権限セキュリティー認証情報で使用します。

| フィールド | 説明 | IAM に必要 | STS に必要 |

|---|---|---|---|

| AWS_ACCESS_KEY_ID |

システムの | はい | いいえ |

| AWS_SECRET_ACCESS_KEY |

システムの | はい | いいえ |

| AWS_BUCKET |

アセット用のシステムの | はい | はい |

| AWS_REGION |

アセット用のシステムの | はい | はい |

| AWS_HOSTNAME | デフォルト: Amazon エンドポイント - AWS S3 互換プロバイダーエンドポイントのホスト名 | いいえ | いいえ |

| AWS_PROTOCOL |

デフォルト: | いいえ | いいえ |

| AWS_PATH_STYLE |

デフォルト: | いいえ | いいえ |

| AWS_ROLE_ARN | AWS STS を使用して認証するためのポリシーがアタッチされているロールの ARN | いいえ | はい |

| AWS_WEB_IDENTITY_TOKEN_FILE |

マウントされたトークンファイルの場所へのパス。例: | いいえ | はい |

2.5.11. PostgreSQL のインストール

MySQL 内部リレーショナルデータベースがデフォルトのデプロイメントです。このデプロイメント設定をオーバーライドして、代わりに PostgreSQL を使用することができます。

関連情報

- 詳細は、APIManager DatabaseSpec を参照してください。

2.5.12. SMTP 変数の設定 (任意)

3scale は、電子メールを使用して、通知を送信 し、新しいユーザーを招待 します。この機能を使用する場合は、独自の SMTP サーバーを提供し、system-smtp シークレットで SMTP 変数を設定する必要があります。

system-smtp シークレットで SMTP 変数を設定するには、次の手順を実行します。

手順

OpenShift にログインしていない場合はログインします。

oc login

$ oc loginCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc patchコマンドを使用して、system-smtpがシークレットの名前であるシークレットタイプを指定し、その後に-pオプションを付けて、次の変数の JSON に新しい値を書き込みます。Expand 表2.2 system-smtp フィールド 説明 デフォルト値 addressこれは、使用するリモートメールサーバーのアドレス (ホスト名または IP) です。これが

""以外の値に設定されている場合、システムはメールサーバーを使用して、API 管理ソリューションで発生するイベントに関連するメールを送信します。""portこれは、使用するリモートメールサーバーのポートです。

""domainメールサーバーで HELO ドメインが必要な場合は、

domainを使用します。""認証メールサーバーで認証が必要な場合に使用します。認証タイプを設定します。plain はパスワードを

plainで送信し、loginは Base64 エンコードされたパスワードを送信します。cram_md5は HMAC-MD5 アルゴリズムに基づくチャレンジ/レスポンスメカニズムを組み合わせます。""usernameメールサーバーが認証を必要とし、認証タイプがそれを必要とする場合は、

usernameを使用します。""passwordメールサーバーが認証を必要とし、認証タイプがそれを必要とする場合は、

passwordを使用します。""openssl.verify.modeTLS を使用する場合、OpenSSL が証明書をチェックする方法を設定できます。これは、自己署名証明書やワイルドカード証明書を検証する必要がある場合に役立ちます。OpenSSL 検証定数の名前

noneまたはpeerを使用できます。""from_address無返信メールの

fromアドレス値。""例

oc patch secret system-smtp -p '{"stringData":{"address":"<your_address>"}}' oc patch secret system-smtp -p '{"stringData":{"username":"<your_username>"}}' oc patch secret system-smtp -p '{"stringData":{"password":"<your_password>"}}'$ oc patch secret system-smtp -p '{"stringData":{"address":"<your_address>"}}' $ oc patch secret system-smtp -p '{"stringData":{"username":"<your_username>"}}' $ oc patch secret system-smtp -p '{"stringData":{"password":"<your_password>"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow secret 変数を設定した後、

system-appおよびsystem-sidekiqPod を再デプロイします。oc rollout latest dc/system-app oc rollout latest dc/system-sidekiq

$ oc rollout latest dc/system-app $ oc rollout latest dc/system-sidekiqCopy to Clipboard Copied! Toggle word wrap Toggle overflow ロールアウトのステータスを表示し、読み込みが完了したことを確認します。

oc rollout status dc/system-app oc rollout status dc/system-sidekiq

$ oc rollout status dc/system-app $ oc rollout status dc/system-sidekiqCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.13. コンポーネントレベルでのコンピュートリソース要件のカスタマイズ

APIManager カスタムリソース (CR) 属性を使用して、3scale ソリューションの Kubernetes コンピュートリソース要件 をカスタマイズします。この操作により、特定の APIManager コンポーネントに割り当てられるコンピュートリソース (CPU およびメモリー) の要件をカスタマイズします。

以下の例で、backend-listener および zync-database の system-master の system-provider コンテナーに対するコンピュートリソース要件をカスタマイズする方法の概要を説明します。

関連情報

コンポーネントレベルの CR 要件を指定する方法の詳細は、APIManager CRD リファレンス を参照してください。

2.5.13.1. APIManager コンポーネントのデフォルトコンピュートリソース

APIManager の spec.resourceRequirementsEnabled 属性を true に設定すると、デフォルトのコンピュートリソースが APIManager コンポーネントに設定されます。

以下の表に、APIManager コンポーネントに設定された特定のコンピュートリソースのデフォルト値をまとめます。

2.5.13.1.1. CPU およびメモリーの単位

コンピュートリソースのデフォルト値の表に使用される単位について、以下のリストにまとめます。CPU およびメモリーの単位の詳細は、Managing Resources for Containers を参照してください。

リソースの単位について

- m: ミリ CPU またはミリコア

- Mi: メビバイト

- Gi: ギビバイト

- G: ギガバイト

| コンポーネント | CPU 要求 | CPU 上限 | メモリー要求 | メモリー上限 |

|---|---|---|---|---|

| system-app の system-master | 50 m | 1000 m | 600 Mi | 800 Mi |

| system-app の system-provider | 50 m | 1000 m | 600 Mi | 800 Mi |

| system-app の system-developer | 50 m | 1000 m | 600 Mi | 800 Mi |

| system-sidekiq | 100 m | 1000 m | 500 Mi | 2 Gi |

| system-sphinx | 80 m | 1000 m | 250 Mi | 512 Mi |

| system-redis | 150 m | 500 m | 256 Mi | 32 Gi |

| system-mysql | 250 m | 制限なし | 512 Mi | 2 Gi |

| system-postgresql | 250 m | 制限なし | 512 Mi | 2 Gi |

| backend-listener | 500 m | 1000 m | 550 Mi | 700 Mi |

| backend-worker | 150 m | 1000 m | 50 Mi | 300 Mi |

| backend-cron | 50 m | 150 m | 40 Mi | 80 Mi |

| backend-redis | 1000 m | 2000 m | 1024 Mi | 32 Gi |

| apicast-production | 500 m | 1000 m | 64 Mi | 128 Mi |

| apicast-staging | 50 m | 100 m | 64 Mi | 128 Mi |

| zync | 150 m | 1 | 250 M | 512 Mi |

| zync-que | 250 m | 1 | 250 M | 512 Mi |

| zync-database | 50 m | 250 m | 250 M | 2 G |

2.5.14. コンポーネントレベルでのノードのアフィニティーおよび容認のカスタマイズ

APIManager CR 属性を使用して Red Hat 3scale API Management ソリューションの Kubernetes の アフィニティー および 容認 をカスタマイズし、インストールのさまざまな 3scale コンポーネントが Kubernetes ノードにスケジュールされる場所および方法をカスタマイズします。

以下の例では、バックエンドのカスタムノードのアフィニティーを設定します。また、system-memcached のリスナーおよびカスタム容認も設定します。

関連情報

アフィニティーおよび容認に関連する属性の完全リストは、APIManager CRD を参照してください。

2.5.15. 調整

3scale をインストールしたら、3scale operator により、カスタムリソース (CR) からの特定パラメーターセットを更新してシステム設定オプションを変更することができます。変更は ホットスワップ により行われます。つまり、システムの停止やシャットダウンは発生しません。

APIManager カスタムリソース定義 (CRD) のパラメーターがすべて調整可能な訳ではありません。

調整可能なパラメーターのリストを以下に示します。

2.5.15.1. 関連情報

すべての 3scale コンポーネントに対するリソースの制限およびリクエスト

2.5.15.2. バックエンドレプリカ

バックエンド コンポーネントの Pod 数

2.5.15.3. APIcast レプリカ

APIcast ステージングおよび実稼働環境コンポーネントの Pod 数

2.5.15.4. システムレプリカ

システム アプリケーションおよびシステム sidekiq コンポーネントの Pod 数

2.5.15.5. Zync レプリカ

Zync アプリケーションと que コンポーネントの Pod 数

2.6. システムデータベースに Oracle を使用する 3scale の operator によるインストール

Red Hat 3scale API Management 管理者は、Oracle Database を使用する 3scale を operator によりインストールすることができます。デフォルトでは、3scale 2.13 には設定データを MySQL データベースに保管する system というコンポーネントが含まれています。このデフォルトのデータベースをオーバーライドし、情報を外部の Oracle Database に保管することができます。

- operator のみで 3scale のインストールを実行する場合には、Oracle Database は OpenShift Container Platform (OCP) のバージョン 4.2 および 4.3 ではサポートされません。詳細は、Red Hat 3scale API Management のサポート対象構成 を参照してください。

-

このドキュメントでは、レジストリー URL の例として

myregistry.example.comが使用されています。これは、お使いのレジストリー URL に置き換えてください。 - 免責事項: ここに記載されている外部 Web サイトへのリンクは、お客様の利便性のみを目的として提供されています。Red Hat はリンクの内容を確認しておらず、コンテンツまたは可用性について責任を負わないものとします。外部 Web サイトへのリンクが含まれていても、Red Hat が Web サイトまたはその組織、製品、もしくはサービスを保証することを意味するものではありません。お客様は、外部サイトまたはコンテンツの使用 (または信頼) によって生じる損失または費用について、Red Hat が責任を負わないことに同意するものとします。

前提条件

- 3scale がインストールされる OCP クラスターからアクセスすることのできる、コンテナーイメージをプッシュするためのコンテナーレジストリー

- 以下の手順で作成されるため、APIManager CR をインストールしないでください。

- 3scale 用レジストリーサービスアカウント

- OpenShift クラスターからアクセスできる Oracle Database のサポート対象バージョン

-

インストール手順のための Oracle Database

SYSTEMユーザーへのアクセス。

システムデータベースに Oracle を使用する 3scale を operator によりインストールするには、以下の手順を使用します。

2.6.1. Oracle Database の準備

3scale 管理者は、システムコンポーネントに Oracle Database を使用することを決定した場合、3scale インストール用に Oracle Database を完全に準備する必要があります。

手順

- 新しいデータベースを作成します。

次の設定を適用します。

ALTER SYSTEM SET max_string_size=extended SCOPE=SPFILE;

ALTER SYSTEM SET max_string_size=extended SCOPE=SPFILE;Copy to Clipboard Copied! Toggle word wrap Toggle overflow データベースユーザーを設定します。

3scale で Oracle Database インテグレーションをセットアップするには、Oracle

SYSTEMユーザーパスワードを指定する場合と指定しない場合の 2 つのオプションがあります。3scale は、通常のユーザーを作成し、それに必要な権限を付与する初期セットアップでのみ

SYSTEMユーザーを使用します。次の SQL コマンドは、適切な権限を持つ通常のユーザーをセットアップします。({DB_USER}と{DB_PASSWORD}は、実際の値に置き換える必要があるプレースホルダーです)。Copy to Clipboard Copied! Toggle word wrap Toggle overflow SYSTEMユーザーの使用:-

system-databaseシークレットのORACLE_SYSTEM_PASSWORDフィールドにSYSTEMユーザーのパスワードを指定します。 - インストール前に通常のユーザーが存在する必要はありません。これは 3scale 初期化スクリプトによって作成されます。

-

system-databaseシークレットのURLフィールドの接続文字列 (例:oracle-enhanced://{DB_USER}:{DB_PASSWORD}@{DB_HOST}:{DB_PORT}/{DB_NAME}) に、通常のユーザー用の必要なユーザー名とパスワードを入力します。 -

通常の Oracle Database 非システムユーザーのパスワードは一意である必要があり、

SYSTEMユーザーのパスワードとは一致しないようにする必要があります。 指定されたユーザー名を持つユーザーがすでに存在する場合、3scale 初期化スクリプトは次のコマンドを使用して、パスワードの更新を試みます。

ALTER USER {DB_USER} IDENTIFIED BY {DB_PASSWORD}ALTER USER {DB_USER} IDENTIFIED BY {DB_PASSWORD}Copy to Clipboard Copied! Toggle word wrap Toggle overflow パラメーター

PASSWORD_REUSE_TIMEおよびPASSWORD_REUSE_MAXが同じパスワードの再利用を制限するように設定されている場合、データベース設定によっては、このコマンドが正常に完了しない場合があります。

-

通常のデータベースユーザーの手動セットアップ:

-

system-databaseシークレットにORACLE_SYSTEM_PASSWORDを指定する必要はありません。 -

system-databaseシークレットのURLフィールドの接続文字列で指定された通常のデータベースユーザー (SYSTEM以外) は、3scale のインストール前に存在している必要があります。 - インストールに使用する通常のユーザーは、上記のすべての権限を持っている必要があります。

-

関連情報

- 新しいデータベースの作成については、Oracle Database 19c ドキュメントを参照してください。

2.6.2. カスタムシステムコンテナーイメージの作成

手順

GitHub リポジトリーから 3scale OpenShift テンプレートをダウンロードし、アーカイブをデプロイメントします。

tar -xzf 3scale-2.13.0-GA.tar.gz

tar -xzf 3scale-2.13.0-GA.tar.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow Instant Client Downloads ページから、以下をダウンロードします。

- クライアント: basic-lite または basic のいずれか

- ODBC ドライバー

Oracle Database 19c の SDK

- 3scale の場合は、Instant Client Downloads for Linux x86-64(64-bit) を使用します。

- ppc64le および 3scale の場合は、Power Little Endian (64 ビット) 上の Linux の Oracle Instant Client Downloads for Linux を使用します。

次の Oracle ソフトウェアコンポーネントのバージョンについては、表を確認してください。

- Oracle Instant Client パッケージ: Basic または Basic Light

- Oracle Instant Client パッケージ: SDK

Oracle Instant Client パッケージ: ODBC

Expand 表2.4 3scale 向けの Oracle 19c パッケージの例 Oracle 19c パッケージ名 圧縮ファイル名 Basic

instantclient-basic-linux.x64-19.8.0.0.0dbru.zip

Basic Light

instantclient-basiclite-linux.x64-19.8.0.0.0dbru.zip

SDK

instantclient-sdk-linux.x64-19.8.0.0.0dbru.zip

ODBC

instantclient-odbc-linux.x64-19.8.0.0.0dbru.zip

Expand 表2.5 ppc64le および 3scale 用 Oracle 19c パッケージの例 Oracle 19c パッケージ名 圧縮ファイル名 Basic

instantclient-basic-linux.leppc64.c64-19.3.0.0.0dbru.zip

Basic Light

instantclient-basiclite-linux.leppc64.c64-19.3.0.0.0dbru.zip

SDK

instantclient-sdk-linux.leppc64.c64-19.3.0.0.0dbru.zip

ODBC

instantclient-odbc-linux.leppc64.c64-19.3.0.0.0dbru.zip

注記ローカルにダウンロードされて保存されたクライアントパッケージバージョンが、3scale が想定するバージョンと一致しない場合には、以下の手順で 3scale は適切なバージョンを自動的にダウンロードして使用します。

-

Oracle Database Instant Client Package ファイルを

system-oracle-3scale-2.13.0-GA/oracle-client-filesディレクトリーに配置します。 レジストリーサービスアカウントの作成 で作成したクレデンシャルを使用して、

registry.redhat.ioアカウントにログインします。docker login registry.redhat.io

$ docker login registry.redhat.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow システムの Oracle ベースのカスタムイメージをビルドします。以下の例に示すように、固定のイメージタグを設定する必要があります。

docker build . --tag myregistry.example.com/system-oracle:2.13.0-1

$ docker build . --tag myregistry.example.com/system-oracle:2.13.0-1Copy to Clipboard Copied! Toggle word wrap Toggle overflow システムの Oracle ベースのイメージを、OCP クラスターからアクセス可能なコンテナーレジストリーにプッシュします。このコンテナーレジストリーに、この後 3scale ソリューションがインストールされます。

docker push myregistry.example.com/system-oracle:2.13.0-1

$ docker push myregistry.example.com/system-oracle:2.13.0-1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6.3. operator を使用した Oracle での 3scale のインストール

手順

-

該当するフィールドを使用して

system-databaseシークレットを作成し、Oracle Database URL の接続文字列および Oracle Database のシステムパスワードを設定します。Oracle Database については、外部データベースモードでのインストール を参照してください。 APIManager CR を作成して、3scale ソリューションをインストールします。operator を使用した 3scale のデプロイ に記載の手順に従います。

APIManager CR は、以前にビルドしたシステムの Oracle ベースのイメージに設定された

.spec.system.imageフィールドを指定する必要があります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7. 典型的な 3scale インストールの問題のトラブルシューティング

本セクションでは、典型的なインストールの問題と、その問題を解決するためのアドバイスについて説明します。

2.7.1. 以前のデプロイメントがダーティーな永続ボリューム要求を残す

問題

以前のデプロイメントがダーティーな永続ボリューム要求 (PVC) を残そうとするため、MySQL コンテナーの起動に失敗する。

原因

OpenShift のプロジェクトを削除しても、それに関連する PVC は消去されない。

解決方法

手順

oc get pvcコマンドを使用してエラーのある MySQL データが含まれる PVC を探します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

OpenShift UI の

cancel deploymentをクリックして、system-mysql Pod のデプロイメントを停止します。 - MySQL パス以下にあるものすべてを削除し、ボリュームをクリーンアップします。

-

新たに

system-mysqlのデプロイメントを開始します。

2.7.2. 認証されたイメージレジストリーの認証情報が間違っているか、欠落している

問題

Pod が起動していません。ImageStreams に次のエラーが表示されます。

! error: Import failed (InternalError): ...unauthorized: Please login to the Red Hat Registry

! error: Import failed (InternalError): ...unauthorized: Please login to the Red Hat Registry原因

OpenShift 4.x に 3scale をインストールすると、ImageStreams が参照するイメージをプルできないため、OpenShift は Pod の起動に失敗します。これは、Pod が指しているレジストリーに対して認証できないために発生します。

解決方法

手順

次のコマンドを入力して、コンテナーレジストリー認証の設定を確認します。

oc get secret

$ oc get secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットが存在する場合は、ターミナルに次の出力が表示されます。

threescale-registry-auth kubernetes.io/dockerconfigjson 1 4m9s

threescale-registry-auth kubernetes.io/dockerconfigjson 1 4m9sCopy to Clipboard Copied! Toggle word wrap Toggle overflow - ただし、出力が表示されない場合は、次の操作を行う必要があります。

- レジストリーサービスアカウントの作成 中に以前に設定した認証情報を使用して、シークレットを作成します。

-

提供されている

oc create secretコマンドの<your-registry-service-account-username>および<your-registry-service-account-password>を置き換えて、OpenShift でのレジストリー認証の設定 の手順を使用します。 APIManager リソースと同じ namespace で

threescale-registry-authシークレットを生成します。<project-name>内で次を実行する必要があります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow APIManager リソースを削除して再作成します。

oc delete -f apimanager.yaml apimanager.apps.3scale.net "example-apimanager" deleted oc create -f apimanager.yaml apimanager.apps.3scale.net/example-apimanager created

$ oc delete -f apimanager.yaml apimanager.apps.3scale.net "example-apimanager" deleted $ oc create -f apimanager.yaml apimanager.apps.3scale.net/example-apimanager createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

次のコマンドを入力して、デプロイのステータスが

StartingまたはReadyであることを確認します。その後、Pod が以下を生成し始めます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、各 Pod のステータスを確認します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7.3. 誤って Docker レジストリーからプルされる

問題

インストール中に以下のエラーが発生する。

svc/system-redis - 1EX.AMP.LE.IP:6379

dc/system-redis deploys docker.io/rhscl/redis-32-rhel7:3.2-5.3

deployment #1 failed 13 minutes ago: config change

svc/system-redis - 1EX.AMP.LE.IP:6379

dc/system-redis deploys docker.io/rhscl/redis-32-rhel7:3.2-5.3

deployment #1 failed 13 minutes ago: config change原因

OpenShift は docker コマンドを実行し、コンテナーイメージを検索およびプルします。このコマンドは、registry.redhat.io Red Hat Ecosystem Catalog ではなく、docker.io Docker レジストリーを参照します。

これは、システムに予期せぬバージョンの Docker コンテナー環境が含まれる場合に発生します。

解決方法

手順

適切なバージョン の Docker コンテナー環境を使用します。

2.7.4. 永続ボリュームがローカルでマウントされている場合の MySQL の権限の問題

問題

system-msql Pod がクラッシュし、デプロイされないため、それに依存する他のシステムのデプロイメントに失敗する。Pod ログに以下のエラーが記録される。

[ERROR] Cannot start server : on unix socket: Permission denied [ERROR] Do you already have another mysqld server running on socket: /var/lib/mysql/mysql.sock ? [ERROR] Aborting

[ERROR] Cannot start server : on unix socket: Permission denied

[ERROR] Do you already have another mysqld server running on socket: /var/lib/mysql/mysql.sock ?

[ERROR] Aborting原因

MySQL プロセスが不適切なユーザー権限で起動されている。

解決方法

手順

永続ボリュームに使用されるディレクトリーには、root グループの書き込み権限が必要です。MySQL サービスは root グループの別のユーザーとして実行されるため、root ユーザーの読み取り/書き込み権限では不十分です。root ユーザーとして以下のコマンドを実行します。

chmod -R g+w /path/for/pvs

chmod -R g+w /path/for/pvsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、SELinux がアクセスをブロックしないようにします。

chcon -Rt svirt_sandbox_file_t /path/for/pvs

chcon -Rt svirt_sandbox_file_t /path/for/pvsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7.5. ロゴまたはイメージをアップロードできない

問題

ロゴをアップロードできず、system-app ログに以下のエラーが表示される。

Errno::EACCES (Permission denied @ dir_s_mkdir - /opt/system/public//system/provider-name/2

Errno::EACCES (Permission denied @ dir_s_mkdir - /opt/system/public//system/provider-name/2原因

OpenShift が永続ボリュームに書き込みを行うことができない。

解決方法

手順

OpenShift が永続ボリュームに書き込みを行えるようにします。永続ボリュームのグループ所有者を root グループにし、またグループによる書き込みを可能にしなければなりません。

2.7.6. OpenShift でテストコールが動作しない

問題

OpenShift で新しいサービスとルートを作成した後に、テストコールが動作しない。curl 経由のダイレクトコールも失敗し、service not available が出力される。

原因

3scale はデフォルトで HTTPS ルートが必要で、OpenShift ルートはセキュアではない。

解決方法

手順

OpenShift のルーター設定で secure route チェックボックスが選択されていることを確認します。

2.7.7. 3scale 以外のプロジェクトでの APIcast デプロイに失敗する

問題

APIcast のデプロイに失敗する (Pod が青にならない)。以下のエラーがログに表示される。

update acceptor rejected apicast-3: pods for deployment "apicast-3" took longer than 600 seconds to become ready

update acceptor rejected apicast-3: pods for deployment "apicast-3" took longer than 600 seconds to become ready以下のエラーが Pod に表示される。

Error synching pod, skipping: failed to "StartContainer" for "apicast" with RunContainerError: "GenerateRunContainerOptions: secrets \"apicast-configuration-url-secret\" not found"

Error synching pod, skipping: failed to "StartContainer" for "apicast" with RunContainerError: "GenerateRunContainerOptions: secrets \"apicast-configuration-url-secret\" not found"原因

シークレットが適切に設定されていない。

解決方法

手順

APIcast v3 でシークレットを作成する時に apicast-configuration-url-secret を指定します。

oc create secret generic apicast-configuration-url-secret --from-literal=password=https://<ACCESS_TOKEN>@<TENANT_NAME>-admin.<WILDCARD_DOMAIN>

oc create secret generic apicast-configuration-url-secret --from-literal=password=https://<ACCESS_TOKEN>@<TENANT_NAME>-admin.<WILDCARD_DOMAIN>2.8. 関連情報

第3章 APIcast のインストール

APIcast は、内部および外部の API サービスを Red Hat 3scale API Management Platform と統合するのに使用される NGINX ベースの API ゲートウェイです。APIcast は、ラウンドロビン形式で負荷分散を行います。

本章では、デプロイメントオプション、提供される環境、および使用を開始する方法について説明します。

前提条件

APIcast がスタンドアロンの API ゲートウェイではない。また、3scale API Manager への接続が必要である。

- 稼働中の オンプレミス型 3scale インスタンス

APIcast をインストールするには、以下のセクションに概略を示す手順を実施します。

3.1. APIcast デプロイメントのオプション

Hosted APIcast (ホスト型 APIcast) または Self-managed APIcast (自己管理型 APIcast) を使用できます。どちらの場合にも、APIcast は残りの 3scale API Management プラットフォームに接続している必要があります。

- Embedded APIcast: 3scale API Management インストールには、ステージングと実稼働の 2 つのデフォルト APIcast ゲートウェイが含まれています。これらのゲートウェイは事前設定された状態で提供され、すぐに使用できます。

Self-managed APIcast (自己管理型 APIcast): APIcast をどこにでもデプロイすることができます。APIcast をデプロイするための推奨オプションの 1 つを次に示します。

- Red Hat OpenShift 上で APIcast を実行する: APIcast を サポート対象バージョン の OpenShift で実行します。Self-managed APIcast は、オンプレミス型 3scale インストール環境またはホスト型 3scale (SaaS) アカウントに接続できます。このために、operator を使用して APIcast ゲートウェイのセルフマネージドソリューションをデプロイ します。

3.2. APIcast の環境

デフォルトでは、3scale アカウントを作成すると、2 つの異なる環境の Embedded APIcast が提供されます。

- ステージング: API インテグレーションの設定中またはテスト中にのみ使用することが目的です。設定が想定どおりに動作していることが確認されたら、実稼働環境にデプロイすることができます。

-

実稼働: 実稼働向けの環境です。

APICAST_CONFIGURATION_LOADER: bootおよびAPICAST_CONFIGURATION_CACHE: 300パラメーターは、OpenShift テンプレートの実稼働 APIcast のために設定されています。そのため、APIcast の開始時に設定が完全に読み込まれ、300 秒 (5 分) 間キャッシュに保存されます。設定は 5 分後に再読み込みされます。これにより、設定を実稼働環境にプロモートすると、APIcast の新しいデプロイメントを実行しない限り、設定の適用に 5 分程度かかる場合があります。

3.3. インテグレーション設定

3scale 管理者は、3scale を実行する必要のある環境のインテグレーション設定を行います。

前提条件

管理者権限が設定された 3scale アカウント

手順

- [Your_product_name] > Integration > Settings の順に移動します。

Deployment セクションでは、デフォルトのオプションは以下のとおりです。

- Deployment Option: APIcast 3scale managed

- 認証モード: API キー

- 希望するオプションに変更します。

- 変更を保存するには、Update Product をクリックします。

3.4. 製品の設定

Private Base URL フィールドに API バックエンドのエンドポイントホストを指定して、API バックエンドを宣言する必要があります。すべての認証、承認、流量制御、および統計が処理された後、APIcast はすべてのトラフィックを API バックエンドにリダイレクトします。

本セクションでは、製品の設定について各手順を説明します。

3.4.1. API バックエンドの宣言

通常、API のプライベートベース URL は、管理するドメイン (yourdomain.com) 上で https://api-backend.yourdomain.com:443 のようになります。たとえば、Twitter API と統合する場合、プライベートベース URL は https://api.twitter.com/ になります。

この例では、3scale がホストする Echo API を使用します。これは、任意のパスを受け入れ、リクエストに関する情報 (パス、リクエストパラメーター、ヘッダーなど) を返すシンプルな API です。このプライベートベース URL は https://echo-api.3scale.net:443 になります。

手順

プライベート (アンマネージド) API が動作することをテストします。たとえば、Echo API の場合には

curlコマンドを使用して以下の呼び出しを行うことができます。curl "https://echo-api.3scale.net:443"

$ curl "https://echo-api.3scale.net:443"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のレスポンスが返されます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.2. 認証の設定

API の認証設定は [Your_product_name] > Integration > Settings の AUTHENTICATION セクションで行うことができます。

| フィールド | 説明 |

|---|---|

| Auth user key | Credentials location に関連付けられたキーを設定します。 |

| Credentials location | クレデンシャルが HTTP ヘッダー、クエリーパラメーター、または HTTP Basic 認証として渡されるかどうかを定義します。 |

| Host Header | カスタムの Host リクエストヘッダーを定義します。これは、API バックエンドが特定のホストからのトラフィックのみを許可する場合に必要です。 |

| Secret Token | API バックエンドに直接送られる開発者リクエストをブロックするために使用します。ここにヘッダーの値を設定し、バックエンドがこのシークレットヘッダーを持つ呼び出しのみを許可するようにします。 |

さらに [Your_product_name] > Integration > Settings の順に移動し、GATEWAY RESPONSE エラーコードを設定できます。エラー発生時 (認証失敗、認証パラメーターがない、および一致するルールがない) のResponse Code、Content-type、およびResponse Bodyを定義します。

| レスポンスコード | レスポンスのボディー |

|---|---|

| 403 | Authentication failed |

| 403 | Authentication parameters missing |

| 404 | No Mapping Rule matched |

| 429 | Usage limit exceeded |

3.4.3. API テストコールの設定

API の設定では、リクエストコールを元にテストを行うために、プロダクトを含めたバックエンドのテストを行い、APIcast の設定をステージング環境および実稼働環境にプロモートする必要があります。

それぞれのプロダクトについて、リクエストはパスに従って対応するバックエンドにリダイレクトされます。このパスは、バックエンドをプロダクトに追加する際に設定されます。たとえば、プロダクトに 2 つのバックエンドを追加している場合、それぞれのバックエンドは固有のパスを持ちます。

前提条件

- プロダクトに追加された 1 つまたは複数の バックエンド

- プロダクトに追加された各バックエンドの マッピングルール

- アクセスポリシーを定義するための アプリケーションプラン

- アプリケーションプランを参照する アプリケーション

手順

- [Your_product_name] > Integration > Configuration の順に移動して、APIcast 設定をステージング環境にプロモートします。

APIcast Configuration セクションに、プロダクトに追加された各バックエンドのマッピングルールが表示されます。Promote v.[n] to Staging APIcast をクリックします。

- v.[n] は、プロモート先のバージョン番号を表します。

ステージング環境にプロモートしたら、実稼働環境にプロモートすることができます。Staging APIcast セクションで、Promote v.[n] to Production APIcast をクリックします。

- v.[n] は、プロモート先のバージョン番号を表します。

コマンドラインで API へのリクエストをテストするには、Example curl for testing で提供されるコマンドを使用します。

- curl コマンドの例は、プロダクトの最初のマッピングルールに基づいています。

API へのリクエストをテストする際に、メソッドおよびメトリックを追加して マッピングルールを変更することができます。

設定を変更したら、API への呼び出しを行う前に、必ずステージング環境および実稼働環境にプロモートするようにしてください。ステージング環境にプロモートする保留中の変更がある場合には、管理ポータルの Integration メニュー項目の横に感嘆符が表示されます。

3scale Hosted APIcast ゲートウェイはクレデンシャルを検証し、API のアプリケーションプランで定義した流量制御を適用します。クレデンシャルがない、あるいは無効なクレデンシャルで呼び出しを行うと、エラーメッセージAuthentication failedが表示されます。

3.4.4. Podman への APIcast のデプロイ

ここでは、Pod Manager (Podman) コンテナー環境に Red Hat 3scale API Management API ゲートウェイとして使用される APIcast をデプロイする方法を、手順を追って説明します。

Podman コンテナー環境に APIcast をデプロイする場合、サポートされる Red Hat Enterprise Linux (RHEL) および Podman のバージョンは以下のとおりです。

- RHEL 8.x/9.x

- Podman 4.2.0/4.1.1

前提条件

- 3章APIcast のインストール に従って、3scale 管理ポータルで APIcast を設定している。

Red Hat Ecosystem Catalog へのアクセス

- レジストリーサービスアカウントを作成するには、レジストリーサービスアカウントの作成 を参照してください。

Podman コンテナー環境に APIcast をデプロイするには、以下のセクションに概略を示す手順を実施します。

3.4.4.1. Podman コンテナー環境のインストール

本セクションでは、RHEL 8 に Podman コンテナー環境を設定する手順を説明します。Docker は RHEL 8 に含まれていないため、コンテナーの操作には Podman を使用します。

Podman と RHEL 8 の使用については、コンテナーのコマンドに関するリファレンスドキュメント を参照してください。

手順

Podman コンテナー環境パッケージをインストールします。

sudo dnf install podman

$ sudo dnf install podmanCopy to Clipboard Copied! Toggle word wrap Toggle overflow 関連情報

他のオペレーティングシステムをお使いの場合は、以下の Podman のドキュメントを参照してください。

- Podman Installation Instructions

3.4.4.2. Podman 環境の実行

Podman コンテナー環境を実行するには、以下の手順に従います。

手順

Red Hat レジストリーから、そのまま使用できる Podman コンテナーのイメージをダウンロードします。

podman pull registry.redhat.io/3scale-amp2/apicast-gateway-rhel8:3scale2.13

$ podman pull registry.redhat.io/3scale-amp2/apicast-gateway-rhel8:3scale2.13Copy to Clipboard Copied! Toggle word wrap Toggle overflow Podman で APIcast を実行します。

podman run --name apicast --rm -p 8080:8080 -e THREESCALE_PORTAL_ENDPOINT=https://<access_token>@<domain>-admin.3scale.net registry.redhat.io/3scale-amp2/apicast-gateway-rhel8:3scale2.13

$ podman run --name apicast --rm -p 8080:8080 -e THREESCALE_PORTAL_ENDPOINT=https://<access_token>@<domain>-admin.3scale.net registry.redhat.io/3scale-amp2/apicast-gateway-rhel8:3scale2.13Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここで、

<access_token>は 3scale Account Management API のアクセストークンに置き換えます。アクセストークンの代わりにプロバイダーキーを使用することもできます。<domain>-admin.3scale.netは 3scale 管理ポータルの URL です。

このコマンドは、apicastという Podman コンテナーエンジンをポート 8080 で実行し、3scale 管理ポータルから JSON 設定ファイルを取得します。その他の設定オプションについては、APIcast のインストール を参照してください。

3.4.4.2.1. Podman による APIcast のテスト

以下の手順は、Podman コンテナーエンジンが独自の設定ファイルと、3scale レジストリーからの Podman コンテナーイメージで実行されるようにします。呼び出しは APIcast を介してポート 8080 でテストでき、3scale アカウントから取得できる正しい認証クレデンシャルを提供できます。

テストコールは、APIcast が適切に実行されていることを確認するだけでなく、認証とレポートが正常に処理されたことも確認します。

呼び出しに使用するホストが Integration ページの Public Base URL フィールドに設定されたホストと同じであるようにしてください。

3.4.4.3. podman コマンドのオプション

podman コマンドでは、以下に例を示すオプションを使用することができます。

-

-d: デタッチモード でコンテナーを実行し、コンテナー ID を出力します。このオプションを指定しないと、コンテナーはフォアグラウンドモードで実行され、CTRL+cを使用して停止することができます。デタッチモードで起動された場合、podman attachコマンド (例:podman attach apicast) を使用するとコンテナーに再アタッチすることができます。 -

psおよび-a: Podmanpsを使用して、作成中および実行中のコンテナーをリスト表示します。psコマンドに-aを追加すると (例:podman ps -a)、すべてのコンテナー (実行中および停止中の両方) が表示されます。 -

inspectおよび-l: 実行中のコンテナーを調べます。たとえば、inspectを使用して、コンテナーに割り当てられた ID を表示します。-lを使用すると、最新のコンテナーの詳細を取得できます (たとえばpodman inspect -l | grep Id\":)。

3.4.4.4. 関連情報

3.5. operator を使用した Self-managed APIcast ゲートウェイソリューションのデプロイ

本セクションでは、Openshift Container Platform コンソールから APIcast operator を使用して Self-managed APIcast ゲートウェイソリューションをデプロイする手順について説明します。

デフォルト設定は、APIcast をデプロイするときの実稼働環境用です。これらの設定は、ステージング環境をデプロイするためにいつでも調整できます。たとえば、次の oc コマンドを使用します。

oc patch apicast/{apicast_name} --type=merge -p '{"spec":{"deploymentEnvironment":"staging","configurationLoadMode":"lazy"}}'

$ oc patch apicast/{apicast_name} --type=merge -p '{"spec":{"deploymentEnvironment":"staging","configurationLoadMode":"lazy"}}'詳細については、APIcast カスタムリソース リファレンスを参照してください。

前提条件

- OpenShift Container Platform (OCP) 4 以降およびその管理者権限

- OpenShift への APIcast Operator のインストール の手順に従っている。

手順

- 管理者権限を持つアカウントを使用して OCP コンソールにログインします。

- Operators > Installed Operators の順にクリックします。

- Installed Operators のリストで APIcast Operator をクリックします。

- APIcast > Create APIcast の順にクリックします。

3.5.1. APIcast のデプロイメントおよび設定オプション

Self-managed APIcast ゲートウェイソリューションは、以下に示す 2 とおりの方法を使用してデプロイおよび設定することができます。

以下も参照してください。

3.5.1.1. 3scale システムエンドポイントの指定

手順

3scale システム管理ポータルのエンドポイント情報が含まれる OpenShift シークレットを作成します。

oc create secret generic ${SOME_SECRET_NAME} --from-literal=AdminPortalURL=${MY_3SCALE_URL}$ oc create secret generic ${SOME_SECRET_NAME} --from-literal=AdminPortalURL=${MY_3SCALE_URL}Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

${SOME_SECRET_NAME}はシークレットの名前で、既存のシークレットと競合しない限り、任意の名前を付けることができます。 ${MY_3SCALE_URL}は、3scale アクセストークンおよび 3scale システム管理ポータルのエンドポイントが含まれる URI です。詳細は、THREESCALE_PORTAL_ENDPOINTを参照してください。例

oc create secret generic 3scaleportal --from-literal=AdminPortalURL=https://access-token@account-admin.3scale.net

$ oc create secret generic 3scaleportal --from-literal=AdminPortalURL=https://access-token@account-admin.3scale.netCopy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットの内容についての詳細は、APIcast Custom Resource reference のEmbeddedConfSecret を参照してください。

-

APIcast の OpenShift オブジェクトを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow spec.adminPortalCredentialsRef.nameは、3scale システム管理ポータルのエンドポイント情報が含まれる既存の OpenShift シークレットの名前でなければなりません。APIcast オブジェクトに関連付けられた OpenShift デプロイメントの

readyReplicasフィールドが 1 であることを確認し、APIcast Pod が動作状態にあり準備が整っていることを確認します。そうでなければ、以下のコマンドを使用してフィールドが設定されるまで待ちます。echo $(oc get deployment apicast-example-apicast -o jsonpath='{.status.readyReplicas}') 1$ echo $(oc get deployment apicast-example-apicast -o jsonpath='{.status.readyReplicas}') 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5.1.1.1. APIcast ゲートウェイが動作中で利用可能であることの確認

手順

ローカルマシンから OpenShift Service APIcast にアクセス可能であることを確認し、テストリクエストを実行します。そのために、APIcast OpenShift Service を

localhost:8080にポート転送します。oc port-forward svc/apicast-example-apicast 8080

$ oc port-forward svc/apicast-example-apicast 8080Copy to Clipboard Copied! Toggle word wrap Toggle overflow 設定済みの 3scale サービスにリクエストを送信して、HTTP レスポンスが成功したことを確認します。サービスの

Staging Public Base URLまたはProduction Public Base URL設定で指定したドメイン名を使用します。以下に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5.1.1.2. Kubernetes Ingress 経由での APIcast の外部公開

Kubernetes Ingress 経由で APIcast を外部に公開するには、exposedHost セクションを設定します。ExposedHost セクションの host フィールドを設定すると、Kubernetes Ingress オブジェクトが作成されます。事前にインストールした既存の Kubernetes Ingress Controller はこの Kubernetes Ingress オブジェクトを使用し、APIcast を外部からアクセス可能にします。

APIcast を外部からアクセス可能にするのに使用できる Ingress Controllers およびその設定方法について詳しく知るには、Kubernetes Ingress Controllers のドキュメント を参照してください。

ホスト名 myhostname.com で APIcast を公開する例を以下に示します。

この例では、HTTP 用ポート 80 に Kubernetes Ingress オブジェクトを作成します。APIcast デプロイメントが OpenShift 環境にある場合、OpenShift のデフォルト Ingress Controller は APIcast が作成する Ingress オブジェクト使用して Route オブジェクトを作成し、APIcast インストールへの外部アクセスが可能になります。

exposedHost セクションに TLS を設定することもできます。利用可能なフィールドの詳細を以下の表に示します。

| json/yaml フィールド | タイプ | 必須/任意 | デフォルト値 | 説明 |

|---|---|---|---|---|

|

| string | はい | 該当なし | ゲートウェイにルーティングされているドメイン名 |

|

| []networkv1.IngressTLS | いいえ | 該当なし | 受信 TLS オブジェクトの配列。詳細は、TLS を参照してください。 |

3.5.1.2. 設定シークレットの指定

手順

設定ファイルを使用してシークレットを作成します。

curl https://raw.githubusercontent.com/3scale/APIcast/master/examples/configuration/echo.json -o $PWD/config.json oc create secret generic apicast-echo-api-conf-secret --from-file=$PWD/config.json

$ curl https://raw.githubusercontent.com/3scale/APIcast/master/examples/configuration/echo.json -o $PWD/config.json $ oc create secret generic apicast-echo-api-conf-secret --from-file=$PWD/config.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 設定ファイルは

config.jsonという名前にする必要があります。これは APIcast CRD の要件です。シークレットの内容についての詳細は、APIcast Custom Resource reference のEmbeddedConfSecret を参照してください。

APIcast カスタムリソース を作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 埋め込み設定シークレットの例を以下に示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

APIcast オブジェクトの作成時に以下の内容を設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow spec.embeddedConfigurationSecretRef.nameは、ゲートウェイの設定が含まれる既存の OpenShift シークレットの名前でなければなりません。APIcast オブジェクトに関連付けられた OpenShift デプロイメントの

readyReplicasフィールドが 1 であることを確認し、APIcast Pod が動作状態にあり準備が整っていることを確認します。そうでなければ、以下のコマンドを使用してフィールドが設定されるまで待ちます。echo $(oc get deployment apicast-example-apicast -o jsonpath='{.status.readyReplicas}') 1$ echo $(oc get deployment apicast-example-apicast -o jsonpath='{.status.readyReplicas}') 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5.1.2.1. APIcast ゲートウェイが動作中で利用可能であることの確認

手順

ローカルマシンから OpenShift Service APIcast にアクセス可能であることを確認し、テストリクエストを実行します。そのために、APIcast OpenShift Service を

localhost:8080にポート転送します。oc port-forward svc/apicast-example-apicast 8080

$ oc port-forward svc/apicast-example-apicast 8080Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5.1.3. APIcast Operator を使用したカスタム環境の注入

Self-managed APIcast を使用する 3scale インストールでは、3scale Operator を使用してカスタム環境を注入できます。カスタム環境は、ゲートウェイが提供するすべてのアップストリーム API に APIcast が適用する動作を定義します。カスタム環境を作成するには、Lua コードでグローバル設定を定義します。

APIcast のインストールの一部として、またはインストール後にカスタム環境を注入できます。カスタム環境を注入した後、その環境を削除すると、APIcast Operator が変更を調整します。

前提条件

- APIcast Operator がインストールされている。

手順

注入するカスタム環境を定義する Lua コードを記述します。たとえば、次の

env1.luaファイルは、APIcastOperator がすべてのサービスに対してロードするカスタムログポリシーを示しています。Copy to Clipboard Copied! Toggle word wrap Toggle overflow カスタム環境を定義する Lua ファイルからシークレットを作成します。以下に例を示します。

oc create secret generic custom-env-1 --from-file=./env1.lua

$ oc create secret generic custom-env-1 --from-file=./env1.luaCopy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットには複数のカスタム環境を含めることができます。カスタム環境を定義する各ファイルの

-from-fileオプションを指定します。Operator は各カスタム環境をロードします。作成したシークレットを参照する

APIcastカスタムリソースを定義します。以下の例は、カスタム環境を定義するシークレットの参照に関連するコンテンツのみを示しています。Copy to Clipboard Copied! Toggle word wrap Toggle overflow APIcastカスタムリソースは、カスタム環境を定義する複数のシークレットを参照できます。Operator は各カスタム環境をロードします。カスタム環境を追加する

APIcastカスタムリソースを作成します。たとえば、APIcastカスタムリソースをapicast.yamlファイルに保存した場合は、以下のコマンドを実行します。oc apply -f apicast.yaml

$ oc apply -f apicast.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

次のステップ

カスタム環境を更新する場合は、シークレットに更新が含まれるように、必ずそのシークレットを再作成します。APIcast operator は更新の有無を監視し、更新を発見すると自動的に再デプロイします。

3.5.1.4. APIcast operator を使用したカスタムポリシーの注入

Self-managed APIcast を使用する 3scale インストールでは、APIcast operator を使用してカスタムポリシーを注入できます。カスタムポリシーを注入すると、ポリシーコードが APIcast に追加されます。次に、以下のいずれかを使用して、カスタムポリシーを API 製品のポリシーチェーンに追加できます。

- 3scale API

-

Productカスタムリソース

3scale 管理ポータルを使用してカスタムポリシーを製品のポリシーチェーンに追加するには、カスタムポリシーのスキーマを CustomPolicyDefinition カスタムリソースに登録する必要もあります。カスタムポリシー登録は、管理ポータルを使用して製品のポリシーチェーンを設定する場合にのみ必要です。

APIcast のインストールの一部として、またはインストール後にカスタムポリシーを注入できます。カスタムポリシーを注入した後、それを削除すると、APIcast operator が変更を調整します。

前提条件

- APIcast operator がインストールされているか、インストール中である。

-

Write your own policy で説明されているように、カスタムポリシーを定義している。つまり、たとえば、カスタムポリシーを定義する

my-first-custom-policy.lua、apicast-policy.json、およびinit.luaファイルをすでに作成している。

手順

1 つのカスタムポリシーを定義するファイルからシークレットを作成します。以下に例を示します。

oc create secret generic my-first-custom-policy-secret \ --from-file=./apicast-policy.json \ --from-file=./init.lua \ --from-file=./my-first-custom-policy.lua

$ oc create secret generic my-first-custom-policy-secret \ --from-file=./apicast-policy.json \ --from-file=./init.lua \ --from-file=./my-first-custom-policy.luaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 複数のカスタムポリシーがある場合は、カスタムポリシーごとにシークレットを作成します。シークレットには、カスタムポリシーを 1 つだけ含めることができます。

作成したシークレットを参照する

APIcastカスタムリソースを定義します。以下の例は、カスタムポリシーを定義するシークレットの参照に関連するコンテンツのみを示しています。Copy to Clipboard Copied! Toggle word wrap Toggle overflow APIcastカスタムリソースは、カスタムポリシーを定義する複数のシークレットを参照できます。Operator は各カスタムポリシーをロードします。カスタムポリシーを追加する

APIcastカスタムリソースを作成します。たとえば、APIcastカスタムリソースをapicast.yamlファイルに保存した場合は、以下のコマンドを実行します。oc apply -f apicast.yaml

$ oc apply -f apicast.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

次のステップ

カスタムポリシーを更新する場合は、シークレットに更新が含まれるように、必ずそのシークレットを再作成します。APIcast operator は更新の有無を監視し、更新を発見すると自動的に再デプロイします。

3.5.1.5. APIcast operator を使用した OpenTracing の設定

Self-managed APIcast を使用する 3scale のインストールでは、APIcast operator を使用して OpenTracing を設定できます。OpenTracing を有効にすると、APIcast インスタンスに関してより多くの洞察を得て、可観測性を向上できます。

前提条件

-

APIcastoperator がインストールされているか、インストール中である。 - OpenTracing を使用するための APIcast の設定 に記載の前提条件。

- Jaeger がインストールされている。

手順

stringData.configに OpenTracing 設定の詳細を含めて、シークレットを定義します。これは、OpenTracing 設定の詳細が含まれる属性の唯一有効な値です。その他の仕様では、APIcast が OpenTracing 設定の詳細を受け取れないようにします。以下の例は、有効なシークレット定義を示しています。Copy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットを作成します。たとえば、以前のシークレット定義を

myjaeger.yamlファイルに保存した場合は、以下のコマンドを実行します。oc create -f myjaeger.yaml

$ oc create -f myjaeger.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenTracing属性を指定するAPIcastカスタムリソースを定義します。CR 定義で、spec.tracingConfigSecretRef.name属性を OpenTracing 設定の詳細が含まれるシークレットの名前に設定します。以下の例は、OpenTracing の設定に関するコンテンツのみを示しています。Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenTracing を設定する

APIcastカスタムリソースを作成します。たとえば、APIcastカスタムリソースをapicast1.yamlファイルに保存した場合は、以下のコマンドを実行するはずです。oc apply -f apicast1.yaml

$ oc apply -f apicast1.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

次のステップ

OpenTracing のインストール方法に応じて、Jaeger サービスユーザーインターフェイスでトレースが表示されるはずです。

3.6. 関連情報

APIcast の最新リリースとサポート対象バージョンについては、以下のアーティクル記事を参照してください。

第4章 3scale での高可用性サポートのための外部 Redis データベース設定

Red Hat は外部 Redis データベースを使用する 3scale の設定をサポートしています。ただし、Hat は、ゼロダウンタイムのための Redis のセットアップ、3scale のバックエンドコンポーネントの設定、または Redis データベースのレプリケーションおよびシャーディングを正式にはサポートしていません。本章に記載の内容は、参照用途としてのみ提供されています。また、3scale では、cluster mode の Redis はサポートされません。

高可用性 (HA) は、OpenShift Container Platform (OCP) によりほとんどのコンポーネントで提供されます。

Red Hat 3scale API Management デプロイメントからデータベースを外部化すると、アプリケーションからの分離とデータベースレベルでのサービス中断に対する回復力が提供されることになります。サービス中断に対する復元力は、データベースをホストするインフラストラクチャーまたはプラットフォームプロバイダーが提供するサービスレベルアグリーメント (SLA) によって異なります。これは 3scale では提供されていません。選択したデプロイメントによって提供されるデータベースの外部化の詳細は、関連ドキュメントを参照してください。

Red Hat 3scale API Management の HA 用外部データベースコンポーネントは、以下のとおりです。

-

backend-redis: 統計ストレージおよび一時ジョブストレージに使用されます。 -

system-redis: 3scale のバックグラウンドジョブの一時ストレージを提供し、system-appPod の Ruby プロセスのメッセージバスとしても使用されます。

backend-redis と system-redis は、どちらもサポートされる Redis Sentinel および Redis Enterprise 用 Redis 高可用性バリアントと共に動作します。

Redis Pod が停止した場合や、OpenShift Container Platform によって停止された場合には、新しい Pod が自動作成されます。データは永続ストレージから復元されるので、Pod は動作し続けます。このような場合、新しい Pod が起動するまでの間、短いダウンタイムが発生します。これは、Redis がマルチマスター設定をサポートしないという制限によるものです。Redis をデプロイしたすべてのノードに Redis イメージを事前にインストールすることで、ダウンタイムを削減することができます。これにより、Pod の再起動にかかる時間が短縮されます。

ゼロダウンタイムとなるよう Redis をセットアップし、3scale のバックエンドコンポーネントを設定します。

前提条件

- 管理者ロールが設定された 3scale アカウント

4.1. ゼロダウンタイムのための Redis 設定

ゼロダウンタイムが必要な場合、3scale 管理者は OCP 外部に Redis を設定します。3scale Pod の設定オプションを使用してこの設定を行うには、いくつかの方法があります。

- 独自の自己管理型 Redis を設定する

- Redis Sentinel を使用する (Redis Sentinel Documentation を参照)

サービスとして提供される Redis:

例:

- Amazon ElastiCache

- Redis Labs

Red Hat は上記のサービスにサポートを提供しません。このようなサービスの言及は、Red Hat による製品やサービスの推奨を意味するものではありません。Red Hat は、Red Hat 外部のコンテンツを使用 (または依存) して発生した損失や費用の責任を負いません。

4.2. 3scale 用バックエンドコンポーネントの設定

3scale 管理者は、backend-cron、backend-listener、および backend-worker のデプロイメント設定で、back-end コンポーネントの環境変数に Redis HA (フェイルオーバー) を設定します。3scale の Redis HA には、これらの設定が必要です。

Redis と Sentinel を使用するには、backend-redisあるいはsystem-redis、またはその両方のシークレットに Sentinel 設定を指定する必要があります。

4.2.1. backend-redis と system-redis シークレットの作成

以下の手順に従い、適宜 backend-redis および system-redis シークレットを作成します。

4.2.2. HA 用 3scale の新規インストールのデプロイ

手順

以下のフィールドを指定して、

backend-redisおよびsystem-redisシークレットを作成します。backend-redis

Copy to Clipboard Copied! Toggle word wrap Toggle overflow system-redis

NAMESPACE SENTINEL_HOSTS SENTINEL_ROLE URL

NAMESPACE SENTINEL_HOSTS SENTINEL_ROLE URLCopy to Clipboard Copied! Toggle word wrap Toggle overflow Redis と Sentinel を設定する場合、