マルチクラスターエンジン

Kubernetes 用のマルチクラスターエンジンを作成および管理する方法について

概要

第1章 Kubernetes Operator のマルチクラスターエンジンの概要

- クラスターライフサイクルのアーキテクチャー

- 認証情報の管理の概要

- 作成されたクラスターの休止 (テクノロジープレビュー)

- テイントおよび容認 (Toleration) を使用したマネージドクラスターの配置

- プロキシー環境でのクラスターの作成

- クラスタープロキシーアドオンの有効化

- 特定のクラスター管理ロールの設定

- クラスターラベルの管理

- マネージドクラスターで実行する Ansible Tower タスクの設定

- ManagedServiceAccount の有効化

- クラスターのアップグレード

- マネージメントからのクラスターの削除

- must gather コマンドを実行したトラブルシューティング

- インストールステータスがインストールまたは保留中の状態のトラブルシューティング

- 再インストールに失敗する場合のトラブルシューティング

- オフラインクラスターのトラブルシューティング

- マネージドクラスターのインポート失敗に関するトラブルシューティング

- Pending Import ステータスのクラスターのトラブルシューティング

- 証明書を変更した後のインポート済みクラスターのオフラインでのトラブルシューティング

- クラスターのステータスが offline から available に変わる場合のトラブルシューティング

- VMware vSphere でのクラスター作成のトラブルシューティング

- ステータスが Pending または Failed のクラスターのコンソールでのトラブルシューティング

- OpenShift Container Platform バージョン 3.11 クラスターのインポートの失敗時のトラブルシューティング

- degraded 状態にある Klusterlet のトラブルシューティング

- クラスターの削除後も namespace が残る

- クラスターのインポート時の auto-import-secret-exists エラー

1.1. Kubernetes operator のマルチクラスターエンジンについて

Kubernetes operator のマルチクラスターエンジンは、Red Hat OpenShift Container Platform にマルチクラスターライフサイクル機能を提供するクラスターライフサイクルの Operator です。The multicluster engine for Kubernetes operator 2.1 support matrix、および Kubernetes operator のマルチクラスターエンジンに関する次のドキュメントを参照してください。

1.1.1. 要件および推奨事項

Kubernetes Operator のマルチクラスターエンジンをインストールする前に、次のシステム設定要件と設定を確認してください。

重要: 2.5 より前の Red Hat Advanced Cluster Management for Kubernetes がインストールされていないクラスターには、Kubernetes Operator 用のマルチクラスターエンジンをインストールする必要があります。バージョン 2.5 以降で Red Hat Advanced Cluster Management を使用している場合、Kubernetes 用のマルチクラスターエンジンはすでにクラスターにインストールされています。

1.1.1.1. サポートされているブラウザーとプラットフォーム

multicluster engine for Kubernetes operator 2.1 support matrix で、サポートされているブラウザーと機能に関する重要な情報を参照してください。

1.1.2. ネットワーク

Kubernetes オペレーターハブクラスターおよびマネージドクラスター用のマルチクラスターエンジンのネットワーク要件について説明します。

重要: 信頼できる CA バンドルは、Kubernetes オペレーターの namespace のマルチクラスターエンジンで使用できますが、その拡張にはネットワークへの変更が必要です。信頼できる CA バンドル ConfigMap は、trusted-ca-bundle のデフォルト名を使用します。この名前は、TRUSTED_CA_BUNDLE という名前の環境変数でオペレーターに提供することで変更できます。詳細については、Red Hat OpenShift Container Platform の ネットワーク セクションの クラスター全体のプロキシーの設定 を参照してください。の上。

1.1.2.1. ハブクラスターのネットワーク設定

ハブクラスターネットワークの設定を参照できます。

次の表のハブクラスターネットワーク要件を参照してください。

| 方向 | 接続 | ポート (指定されている場合) |

|---|---|---|

| 送信 | クラウドプロバイダーの API | |

| Outbound | プロビジョニングしたマネージドクラスターの Kubernetes API サーバー | 6443 |

| 送信および受信 |

マネージドクラスターの | 443 |

| 受信 | マネージドクラスターからの Kubernetes クラスター用のマルチクラスターエンジンの Kubernetes API サーバー | 6443 |

1.1.2.2. マネージドクラスターのネットワーク設定

マネージドクラスターネットワークの要件については、以下の表を参照してください。

| 方向 | 接続 | ポート (指定されている場合) |

|---|---|---|

| 送信および受信 | Kubernetes クラスター用のマルチクラスターエンジンの Kubernetes API サーバー | 6443 |

1.1.2.3. インフラストラクチャーオペレーターを使用してインストールする場合の追加のネットワーク要件

Infrastructure Operator を使用してベアメタルマネージドクラスターをインストールする場合は、以下の表で追加のネットワーク要件について参照してください。

| 方向 | プロトコル | 接続 | ポート (指定されている場合) |

|---|---|---|---|

| ISO/rootfs イメージリポジトリーへのハブクラスターの送信 | HTTPS (非接続環境では HTTP) | Red Hat Advanced Cluster Management ハブで ISO イメージを作成するのに使用します。 | 443 (非接続環境では 80) |

| 単一ノードの OpenShift Container Platform マネージドクラスターでの BMC インターフェイスへのハブクラスター送信 | HTTPS (非接続環境では HTTP) | OpenShift Container Platform クラスターをブートします。 | 443 |

| OpenShift Container Platform マネージドクラスターからハブクラスターへの送信 | HTTPS |

| 443 |

| OpenShift Container Platform マネージドクラスターから ISO/rootfs イメージリポジトリーへの送信 | HTTP、HTTPS、または TLS | rootfs イメージをダウンロードします。 | HTTP 80, HTTPS 443 |

|

OpenShift Container Platform 管理クラスターから | HTTPS/TLS | イメージをダウンロードします | 443 |

1.1.2.4. Hive Operator を使用してインストールする場合の追加のネットワーク要件

Central Infrastructure Management の使用が含まれる Hive Operator を使用してベアメタルマネージドクラスターをインストールする場合は、ハブクラスターと libvirt プロビジョニングホスト間で、レイヤー 2 またはレイヤー 3 のポート接続を設定する必要があります。プロビジョニングホストへのこの接続は、Hive を使用したベースベアメタルクラスターの作成時に必要になります。詳細は、以下の表を参照してください。

| 方向 | プロトコル | 接続 | ポート (指定されている場合) |

|---|---|---|---|

|

| IP |

Hive Operator がインストールされているハブクラスターを、ベアメタルクラスターの作成時にブートストラップとして機能する |

注記:これらの要件はインストール時にのみ適用され、Infrastructure Operator でインストールされたクラスターのアップグレード時には必要ありません。

1.1.2.4.1. ホステッドコントロールプレーンのネットワーク要件 (テクノロジープレビュー)

ホステッドコントロールプレーンを使用する場合、HypershiftDeployment リソースには、次の表に示すエンドポイントへの接続が必要です。

| 方向 | 接続 | ポート (指定されている場合) |

|---|---|---|

| Outbound | OpenShift Container Platform コントロールプレーンおよびワーカーノード | |

| Outbound | Amazon Web Services のホステッドクラスターのみ: AWS API および S3 API へのアウトバウンド接続 | |

| Outbound | Microsoft Azure クラウドサービスのホステッドクラスターのみ: Azure API へのアウトバウンド接続 | |

| Outbound | coreOS の ISO イメージと OpenShift Container Platform Pod のイメージレジストリーを格納する OpenShift Container Platform イメージリポジトリー |

1.1.3. コンソールの概要

OpenShift Container Platform コンソールプラグインは OpenShift Container Platform 4.10 Web コンソールで利用可能であり、統合することができます。この機能を使用するには、コンソールプラグインを有効にしておく必要があります。Kubernetes Operator 用のマルチクラスターエンジンは、Infrastructure および Credentials のナビゲーション項目から特定のコンソール機能を表示します。Red Hat Advanced Cluster Management をインストールすると、より多くのコンソール機能が表示されます。

注記:プラグインが有効になっている OpenShift Container Platform 4.10 の場合は、ドロップダウンメニューから All Clusters を選択することにより、クラスタースイッチャーから OpenShift Container Platform コンソール内で Red Hat Advanced Cluster Management にアクセスできます。

- プラグインを無効にするには、OpenShift Container Platform コンソールの Administrator パースペクティブにいることを確認してください。

- ナビゲーションで Administration を探し、Cluster Settings をクリックし、続いて Configuration タブをクリックします。

-

Configuration resources のリストから、

operator.openshift.ioAPI グループが含まれる Console リソースをクリックします。この API グループには、Web コンソールのクラスター全体の設定が含まれています。 -

Console plug-ins タブをクリックします。

mceプラグインがリスト表示されます。注記: Red Hat Advanced Cluster Management がインストールされている場合は、acmとしても表示されます。 - テーブルからプラグインのステータスを変更します。しばらくすると、コンソールを更新するように求められます。

1.1.4. ロールベースのアクセス制御

Kubernetes Operator のマルチクラスターエンジンは、ロールベースのアクセス制御 (RBAC) をサポートします。ロールによって実行できるアクションが決まります。RBAC は、Red Hat OpenShift Container Platform と同様に Kubernetes の承認メカニズムに基づいています。RBAC の詳細は、OpenShift Container Platform ドキュメント の OpenShift Container Platform RBAC の概要を参照してください。

注記: ユーザーロールのアクセス権がない場合には、コンソールのアクションボタンが無効になります。

コンポーネントでサポートされる RBAC の詳細は、以下のセクションを参照してください。

1.1.4.1. ロールの概要

クラスター別の製品リソースと、スコープに namespace が指定されている製品リソースがあります。アクセス制御に一貫性を持たせるため、クラスターのロールバインドと、namespace のロールバインドをユーザーに適用する必要があります。サポートされている次のロール定義の表リストを表示します。

1.1.4.1.1. ロール定義表

| ロール | 定義 |

|---|---|

|

|

これは OpenShift Container Platform のデフォルトのロールです。 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

admin、edit、および view は OpenShift Container Platform のデフォルトロールです。これらのロールに対して namespace に限定されたバインドが指定されているユーザーは、特定の namespace 内の |

重要:

- ユーザーは OpenShift Container Platform からプロジェクトを作成できます。これにより、namespace の管理者ロール権限が付与されます。

-

ユーザーにクラスターへのロールアクセスがない場合、クラスター名は表示されません。クラスター名は、

-の記号で表示されます。

RBAC はコンソールレベルと API レベルで検証されます。コンソール内のアクションは、ユーザーのアクセスロールの権限に基づいて有効化/無効化できます。製品の特定ライフサイクルの RBAC の詳細は、以下のセクションを参照してください。

1.1.4.1.2. クラスターライフサイクル RBAC

すべてのマネージドクラスターを作成および管理するには、次の情報を参照してください。

以下のコマンドを入力して、クラスターロール

open-cluster-management:cluster-manager-adminにバインドするクラスターロールを作成します。oc create clusterrolebinding <role-binding-name> --clusterrole=open-cluster-management:cluster-manager-admin

oc create clusterrolebinding <role-binding-name> --clusterrole=open-cluster-management:cluster-manager-adminCopy to Clipboard Copied! Toggle word wrap Toggle overflow このロールはスーパーユーザーであるため、すべてのリソースとアクションにアクセスできます。このロールを使用すると、クラスターレベルの

managedclusterリソース、マネージドクラスターを管理するリソースの namespace、namespace 内のリソースを作成できます。また、このロールで、プロバイダー接続、マネージドクラスター作成に使用するベアメタルアセットにアクセスできます。

cluster-nameという名前のマネージドクラスターを管理するには、以下を参照してください。以下のコマンドを入力して、クラスターロール

open-cluster-management:admin:<cluster-name>にバインドするクラスターロールを作成します。oc create clusterrolebinding (role-binding-name) --clusterrole=open-cluster-management:admin:<cluster-name>

oc create clusterrolebinding (role-binding-name) --clusterrole=open-cluster-management:admin:<cluster-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow このロールを使用すると、クラスターレベルの

managedclusterリソースに読み取り/書き込みアクセスができるようになります。managedclusterはクラスターレベルのリソースで、namespace レベルのリソースではないので、このロールが必要です。以下のコマンドを入力して、クラスターロール

adminにバインドする namespace ロールを作成します。oc create rolebinding <role-binding-name> -n <cluster-name> --clusterrole=admin

oc create rolebinding <role-binding-name> -n <cluster-name> --clusterrole=adminCopy to Clipboard Copied! Toggle word wrap Toggle overflow このロールでは、マネージドクラスターの namespace 内にあるリソースに対して読み取り/書き込みアクセスができるようになります。

cluster-nameという名前のマネージドクラスターを表示するには、以下を参照してください。以下のコマンドを入力して、クラスターロール

open-cluster-management:view:<cluster-name>にバインドするクラスターロールを作成します。oc create clusterrolebinding <role-binding-name> --clusterrole=open-cluster-management:view:<cluster-name>

oc create clusterrolebinding <role-binding-name> --clusterrole=open-cluster-management:view:<cluster-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow このロールを使用すると、クラスターレベルの

managedclusterリソースに読み取りアクセスができるようになります。managedclusterはクラスターレベルのリソースで、namespace レベルのリソースではないので、このロールが必要です。以下のコマンドを入力して、クラスターロール

viewにバインドする namespace ロールを作成します。oc create rolebinding <role-binding-name> -n <cluster-name> --clusterrole=view

oc create rolebinding <role-binding-name> -n <cluster-name> --clusterrole=viewCopy to Clipboard Copied! Toggle word wrap Toggle overflow このロールでは、マネージドクラスターの namespace 内にあるリソースに対して読み取り専用アクセスができるようになります。

以下のコマンドを入力して、アクセス可能なマネージドクラスターの一覧を表示します。

oc get managedclusters.clusterview.open-cluster-management.io

oc get managedclusters.clusterview.open-cluster-management.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドは、クラスター管理者権限なしで、管理者およびユーザーが使用できます。

以下のコマンドを入力して、アクセス可能なマネージドクラスターセットの一覧を表示します。

oc get managedclustersets.clusterview.open-cluster-management.io

oc get managedclustersets.clusterview.open-cluster-management.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドは、クラスター管理者権限なしで、管理者およびユーザーが使用できます。

1.1.4.1.2.1. クラスタープール RBAC

以下のクラスタープール RBAC 操作を確認してください。

クラスタープールのプロビジョニングクラスターを使用するには、以下を実行します。

クラスター管理者は、グループにロールを追加してマネージドクラスターセットを作成し、管理者権限をロールに付与します。

以下のコマンドを使用して、

server-foundation-clustersetマネージドクラスターセットにadminパーミッションを付与します。oc adm policy add-cluster-role-to-group open-cluster-management:clusterset-admin:server-foundation-clusterset server-foundation-team-admin

oc adm policy add-cluster-role-to-group open-cluster-management:clusterset-admin:server-foundation-clusterset server-foundation-team-adminCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを使用して、

server-foundation-clustersetマネージドクラスターセットにview権限を付与します。oc adm policy add-cluster-role-to-group open-cluster-management:clusterset-view:server-foundation-clusterset server-foundation-team-user

oc adm policy add-cluster-role-to-group open-cluster-management:clusterset-view:server-foundation-clusterset server-foundation-team-userCopy to Clipboard Copied! Toggle word wrap Toggle overflow

クラスタープールの namespace (

server-foundation-clusterpool) を作成します。以下のコマンドを実行して、

server-foundation-team-adminのserver-foundation-clusterpoolにadmin権限を付与します。oc adm new-project server-foundation-clusterpool oc adm policy add-role-to-group admin server-foundation-team-admin --namespace server-foundation-clusterpool

oc adm new-project server-foundation-clusterpool oc adm policy add-role-to-group admin server-foundation-team-admin --namespace server-foundation-clusterpoolCopy to Clipboard Copied! Toggle word wrap Toggle overflow

チーム管理者として、クラスタープール namespace に、クラスターセットラベル

cluster.open-cluster-management.io/clusterset=server-foundation-clustersetを使用してocp46-aws-clusterpoolという名前のクラスタープールを作成します。-

server-foundation-webhookは、クラスタープールにクラスターセットラベルがあるかどうか、またユーザーにクラスターセットのクラスタープールを作成するパーミッションがあるかどうかを確認します。 -

server-foundation-controllerは、server-foundation-team-userのserver-foundation-clusterpoolnamespace にview権限を付与します。

-

クラスタープールが作成されると、クラスタープールは

clusterdeploymentを作成します。-

server-foundation-controllerは、server-foundation-team-adminのclusterdeploymentnamespace にadminパーミッションを付与します。 server-foundation-controllerは、server-foundation-team-userのclusterdeploymentnamespace にviewパーミッションを付与します。注記:

team-adminおよびteam-userは、clusterpool、clusterdeplymentおよびclusterclaimへのadmin権限があります。

-

クラスターライフサイクルの以下のコンソールおよび API RBAC の表を表示します。

1.1.4.1.2.2. クラスターライフサイクルのコンソール RBAC の表

| リソース | 管理 | 編集 | 表示 |

|---|---|---|---|

| クラスター | read, update, delete | データなし | read |

| クラスターセット | get, update, bind, join | 編集ロールなし | get |

| マネージドクラスター | read, update, delete | 編集ロールなし | get |

| プロバイダー接続 | create, read, update, delete | データなし | read |

| ベアメタルアセット | create, read, update, delete | データなし | read |

1.1.4.1.2.3. クラスターライフサイクルの RBAC API テーブルのテーブル

| API | 管理 | 編集 | 表示 |

|---|---|---|---|

|

| create, read, update, delete | read, update | read |

|

| read | read | read |

|

| update | update | none |

|

| create, read, update, delete | read, update | read |

|

| read | read | read |

|

| create, read, update, delete | read, update | read |

|

| create, read, update, delete | read, update | read |

|

| create, read, update, delete | read, update | read |

|

| create, read, update, delete | read, update | read |

|

| create, read, update, delete | read, update | read |

|

| create, read, update, delete | read, update | read |

|

| create, read, update, delete | read, update | read |

|

| create, read, update, delete | read, update | read |

|

| create, read, update, delete | read, update | read |

1.1.4.1.2.4. 認証情報ロールベースのアクセス制御

認証情報へのアクセスは Kubernetes で制御されます。認証情報は Kubernetes Secret として保存され、セキュリティーを確保します。シークレットへのアクセスには、次のアクセス許可が適用されます。

- namespace でシークレットの作成権限のあるユーザーは認証情報を作成できます。

- namespace でシークレットの読み取り権限のあるユーザーは、認証情報を表示することもできます。

-

Kubernetes ロール

adminおよびeditのあるユーザーは、シークレットの作成と編集が可能です。 -

Kubernetes クラスターロール

viewのあるユーザーは、シークレットの内容を読み取ると、サービスアカウントの認証情報にアクセスできるようになるため、シークレットを表示できません。

1.2. インストール

Kubernetes Operator のマルチクラスターエンジンは、クラスターフリート管理を強化するソフトウェア Operator です。Kubernetes Operator 用のマルチクラスターエンジンは、Red Hat OpenShift Container Platform と、クラウドおよびデータセンター全体の Kubernetes クラスターライフサイクル管理をサポートします。

以下のドキュメントを参照してください。

1.2.1. ネットワーク接続時のオンラインインストール

Kubernetes Operator 用のマルチクラスターエンジンは、Operator Lifecycle Manager とともにインストールされます。このマネージャーは、Kubernetes Operator 用のマルチクラスターエンジンを含むコンポーネントのインストール、アップグレード、および削除を管理します。

必要なアクセス権限: クラスターの管理者

重要:

- 2.5 より前の Red Hat Advanced Cluster Management for Kubernetes がインストールされていないクラスターには、Kubernetes Operator 用のマルチクラスターエンジンをインストールする必要があります。Kubernetes Operator 用のマルチクラスターエンジンは、同じ管理コンポーネントの一部を提供するため、2.5 より前のバージョンでは Red Hat Advanced Cluster Management for Kubernetes と共存できません。これまで Red Hat Advanced Cluster Management をインストールしたことがないクラスターに Kubernetes Operator 用のマルチクラスターエンジンをインストールすることが推奨されます。バージョン 2.5 以降で Red Hat Advanced Cluster Management for Kubernetes を使用している場合、Kubernetes Operator 用のマルチクラスターエンジンはすでにクラスターにインストールされています。

-

OpenShift Container Platform 専用環境の場合は、

cluster-admin権限が必要です。デフォルトで、dedicated-adminロールには OpenShift Container Platform Dedicated 環境で namespace を作成するために必要なパーミッションがありません。 - デフォルトでは、Kubernetes Operator コンポーネント用のマルチクラスターエンジンは、追加の設定なしで OpenShift Container Platform クラスターのワーカーノードにインストールされます。OpenShift Container Platform OperatorHub Web コンソールインターフェイスまたは OpenShift Container Platform CLI を使用して、Kubernetes Operator 用のマルチクラスターエンジンをワーカーノードにインストールできます。

- OpenShift Container Platform クラスターをインフラストラクチャーノードで設定した場合は、OpenShift Container Platform CLI と追加のリソースパラメーターを使用して、Kubernetes Operator 用のマルチクラスターエンジンをそれらのインフラストラクチャーノードにインストールできます。Kubernetes Operator コンポーネント用のすべてのマルチクラスターエンジンがインフラストラクチャーノードをサポートしているわけではないため、インフラストラクチャーノードに Kubernetes Operator 用マルチクラスターエンジンをインストールする場合は、一部のワーカーノードが必要です。詳細は、インフラストラクチャーノードへのマルチクラスターエンジンのインストール セクションを参照してください。

OpenShift Container Platform または Kubernetes のマルチクラスターエンジンによって作成されていない Kubernetes クラスターをインポートする場合は、イメージプルシークレットを設定する必要があります。イメージプルシークレットおよびその他の高度な設定方法については、このドキュメントの 詳細設定 セクションのオプションを参照してください。

1.2.1.1. 前提条件

Kubernetes 用のマルチクラスターエンジンをインストールする前に、次の要件を確認してください。

- RedHat OpenShift Container Platform クラスターは、OpenShift Container Platform コンソールから OperatorHub カタログにある Kubernetes Operator のマルチクラスターエンジンにアクセスできるようにしている。

- catalog.redhat.com へのアクセスがある。

お使いの環境に OpenShift Container Platform バージョン 4.8 以降をデプロイし、OpenShift Container Platform CLI でログインしている。以下の OpenShift Container Platform のインストールドキュメントを参照してください。

-

OpenShift Container Platform のコマンドラインインターフェイス (CLI) は、

ocコマンドを実行できるように設定している。Red Hat OpenShift CLI のインストールおよび設定の詳細は、CLI の使用方法 を参照してください。 - namespace の作成が可能な OpenShift Container Platform の権限を設定している。

- operator の依存関係にアクセスするには、インターネット接続が必要。

OpenShift Container Platform Dedicated 環境にインストールするには、以下を参照してください。

- OpenShift Container Platform Dedicated 環境が設定され、実行している。

-

エンジンのインストール先の OpenShift Container Platform Deplicated 環境での

cluster-adminがある。

- Red Hat OpenShift Container Platform で提供される Assisted Installer を使用してマネージドクラスターを作成する予定の場合は、OpenShift Container Platform ドキュメントの アシステッドインストーラーを使用したインストールの準備 トピックを参照してください。

1.2.1.2. OpenShift Container Platform インストールの確認

レジストリー、ストレージサービスなど、サポート対象の OpenShift Container Platform バージョンがインストールされ、機能する状態である必要があります。OpenShift Container Platform のインストールの詳細は、OpenShift Container Platform のドキュメントを参照してください。

- Kubernetes Operator 用のマルチクラスターエンジンが OpenShift Container Platform クラスターにインストールされていないことを確認します。Kubernetes Operator 用のマルチクラスターエンジンでは、OpenShift Container Platform クラスターごとに 1 つのインストールのみが許可されます。インストールがない場合は、次の手順に進みます。

OpenShift Container Platform クラスターが正しく設定されていることを確認するには、以下のコマンドを使用して OpenShift Container Platform Web コンソールにアクセスします。

kubectl -n openshift-console get route console

kubectl -n openshift-console get route consoleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の出力例を参照してください。

console console-openshift-console.apps.new-coral.purple-chesterfield.com console https reencrypt/Redirect None

console console-openshift-console.apps.new-coral.purple-chesterfield.com console https reencrypt/Redirect NoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

ブラウザーで URL を開き、結果を確認します。コンソール URL の表示が

console-openshift-console.router.default.svc.cluster.localの場合は、Red Hat OpenShift Container Platform のインストール時にopenshift_master_default_subdomainを設定します。https://console-openshift-console.apps.new-coral.purple-chesterfield.comの例を参照してください。

Kubernetes Operator 用のマルチクラスターエンジンのインストールに進むことができます。

1.2.1.3. OperatorHub Web コンソールインターフェイスからのインストール

ベストプラクティス: OpenShift Container Platform ナビゲーションの Administrator ビューから、OpenShift Container Platform で提供される OperatorHub Web コンソールインターフェイスをインストールします。

- Operators > OperatorHub を選択して利用可能な operator のリストにアクセスし、multicluster engine for Kubernetes operator を選択します。

-

Installをクリックします。 Operator Installation ページで、インストールのオプションを選択します。

Namespace:

- Kubernetes Operator エンジンのマルチクラスターエンジンは、独自の namespace またはプロジェクトにインストールする必要があります。

-

デフォルトでは、OperatorHub コンソールのインストールプロセスにより、

multicluster-engineという名前の namespace が作成されます。ベストプラクティス:multicluster-enginenamespace が使用可能な場合は、引き続き使用します。 -

multicluster-engineという名前の namespace が存在する場合は、別の namespace を選択してください。

- チャネル: インストールするリリースに対応するチャネルを選択します。チャネルを選択すると、指定のリリースがインストールされ、そのリリース内の今後のエラータ更新が取得されます。

承認ストラテジー: 承認ストラテジーでは、サブスクライブ先のチャネルまたはリリースに更新を適用するのに必要な人の間のやり取りを特定します。

- そのリリース内の更新が自動的に適用されるようにするには、デフォルトで選択されている Automatic を選択します。

- Manual を選択して、更新が利用可能になると通知を受け取ります。更新がいつ適用されるかについて懸念がある場合は、これがベストプラクティスになる可能性があります。

注記: 次のマイナーリリースにアップグレードするには、OperatorHub ページに戻り、最新リリースの新規チャネルを選択する必要があります。

- Install を選択して変更を適用し、Operator を作成します。

MultiClusterEngine カスタムリソースを作成するには、次のプロセスを参照してください。

- OpenShift Container Platform コンソールナビゲーションで、Installed Operators > multicluster engine for Kubernetes を選択します。

- MultiCluster Engine タブを選択します。

- Create MultiClusterEngine を選択します。

YAML ファイルのデフォルト値を更新します。このドキュメントの MultiClusterEngine advanced configuration のオプションを参照してください。

- 次の例は、エディターにコピーできるデフォルトのテンプレートを示しています。

apiVersion: multicluster.openshift.io/v1 kind: MultiClusterEngine metadata: name: multiclusterengine spec: {}apiVersion: multicluster.openshift.io/v1 kind: MultiClusterEngine metadata: name: multiclusterengine spec: {}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Create を選択して、カスタムリソースを初期化します。Kubernetes Operator エンジン用のマルチクラスターエンジンがビルドされて起動するまで、最大 10 分かかる場合があります。

MultiClusterEngine リソースが作成されると、リソースのステータスが MultiCluster Engine タブで

Availableになります。

1.2.1.4. OpenShift Container Platform CLI からのインストール

Operator 要件が含まれている Kubernetes Operator エンジン namespace 用のマルチクラスターエンジンを作成します。次のコマンドを実行します。ここで、

namespaceは、Kubernetes エンジン namespace のマルチクラスターエンジンの名前です。namespaceの値は、OpenShift Container Platform 環境では プロジェクト と呼ばれる場合があります。oc create namespace <namespace>

oc create namespace <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow プロジェクトの namespace を、作成した namespace に切り替えます。

namespaceは、手順 1 で作成した Kubernetes エンジン用のマルチクラスターエンジンの namespace の名前に置き換えてください。oc project <namespace>

oc project <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow OperatorGroupリソースを設定するために YAML ファイルを作成します。namespace ごとに割り当てることができる Operator グループ は 1 つだけです。defaultはお使いの operator グループ名に置き換えます。namespaceはお使いのプロジェクトの namespace 名に置き換えます。以下の例を参照してください。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して

OperatorGroupリソースを作成します。operator-groupは、作成した operator グループの YAML ファイル名に置き換えます。oc apply -f <path-to-file>/<operator-group>.yaml

oc apply -f <path-to-file>/<operator-group>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform サブスクリプションを設定するための YAML ファイルを作成します。ファイルは以下の例のようになります。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記: インフラストラクチャーノードに Kubernetes エンジン用のマルチクラスターエンジンをインストールする場合は、Operator Lifecycle Manager サブスクリプションの追加設定 セクションを参照してください。

以下のコマンドを実行して OpenShift Container Platform サブスクリプションを作成します。

subscriptionは、作成したサブスクリプションファイル名に置き換えます。oc apply -f <path-to-file>/<subscription>.yaml

oc apply -f <path-to-file>/<subscription>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow YAML ファイルを作成して、

MultiClusterEngineカスタムリソースを設定します。デフォルトのテンプレートは、以下の例のようになります。apiVersion: multicluster.openshift.io/v1 kind: MultiClusterEngine metadata: name: multiclusterengine spec: {}apiVersion: multicluster.openshift.io/v1 kind: MultiClusterEngine metadata: name: multiclusterengine spec: {}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記: インフラストラクチャーノードに Kubernetes Operator 用のマルチクラスターエンジンをインストールするには、MultiClusterEngine カスタムリソースの追加設定 セクションを参照してください。

次のコマンドを実行して、

MultiClusterEngineカスタムリソースを作成します。custom-resourceは、カスタムリソースファイル名に置き換えます。oc apply -f <path-to-file>/<custom-resource>.yaml

oc apply -f <path-to-file>/<custom-resource>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のエラーで、この手順に失敗した場合でも、リソースは作成され、適用されます。リソースが作成されてから数分後にもう一度コマンドを実行します。

error: unable to recognize "./mce.yaml": no matches for kind "MultiClusterEngine" in version "operator.multicluster-engine.io/v1"

error: unable to recognize "./mce.yaml": no matches for kind "MultiClusterEngine" in version "operator.multicluster-engine.io/v1"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行してカスタムリソースを編集します。次のコマンドを実行した後、

MultiClusterEngineカスタムリソースステータスがstatus.phaseフィールドにAvailableとして表示されるまでに最大 10 分かかる場合があります。oc get mce -o=jsonpath='{.items[0].status.phase}'oc get mce -o=jsonpath='{.items[0].status.phase}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Kubernetes Operator 用のマルチクラスターエンジンを再インストールしても、Pod が起動しない場合は、この問題を回避する手順について、再インストールに失敗する場合のトラブルシューティング を参照してください。

注記:

-

ClusterRoleBindingを使用するServiceAccountは、クラスター管理者特権を Kubernetes Operator のマルチクラスターエンジンと、Kubernetes Operator のマルチクラスターエンジンをインストールする namespace にアクセスできるすべてのユーザー認証情報に自動的に付与します。

1.2.1.5. インフラストラクチャーノードへのインストール

OpenShift Container Platform クラスターを、承認された管理コンポーネントを実行するためのインフラストラクチャーノードを組み込むように設定できます。インフラストラクチャーノードでコンポーネントを実行すると、それらの管理コンポーネントを実行しているノードの OpenShift Container Platform サブスクリプションクォータの割り当てる必要がなくなります。

OpenShift Container Platform クラスターにインフラストラクチャーノードを追加した後に、OpenShift Container Platform CLI からのインストール 手順に従い、以下の設定を Operator Lifecycle Manager サブスクリプションおよび MultiClusterEngine カスタムリソースに追加します。

1.2.1.5.1. インフラストラクチャーノードを OpenShift Container Platform クラスターに追加する

OpenShift Container Platform ドキュメントの インフラストラクチャーマシンセットの作成 で説明されている手順に従います。インフラストラクチャーノードは、Kubernetes の taint および label で設定され、管理以外のワークロードがそれらで稼働し続けます。

Kubernetes Operator のマルチクラスターエンジンによって提供されるインフラストラクチャーノードの有効化と互換性を持たせるには、インフラストラクチャーノードに次の taint と label が適用されていることを確認してください。

1.2.1.5.2. Operator Lifecycle Manager サブスクリプションの追加設定

Operator Lifecycle Manager サブスクリプションを適用する前に、以下の追加設定を追加します。

1.2.1.5.3. MultiClusterEngine カスタムリソースの追加設定

MultiClusterEngine カスタムリソースを適用する前に、以下の設定を追加します。

spec:

nodeSelector:

node-role.kubernetes.io/infra: ""

spec:

nodeSelector:

node-role.kubernetes.io/infra: ""1.2.2. ネットワーク切断状態でのインストール

インターネットに接続されていない Red Hat OpenShift Container Platform クラスターに Kubernetes Operator 用のマルチクラスターエンジンをインストールする必要がある場合があります。ネットワーク接続のないエンジンにインストールする手順でも一部、オンラインインストールと同じ手順が必要になります。

重要: 2.5 より前の Red Hat Advanced Cluster Management for Kubernetes がインストールされていないクラスターには、Kubernetes Operator 用のマルチクラスターエンジンをインストールする必要があります。Kubernetes Operator 用のマルチクラスターエンジンは、同じ管理コンポーネントの一部を提供するため、2.5 より前のバージョンでは Red Hat Advanced Cluster Management for Kubernetes と共存できません。これまで Red Hat Advanced Cluster Management をインストールしたことがないクラスターに Kubernetes Operator 用のマルチクラスターエンジンをインストールすることが推奨されます。バージョン 2.5.0 以降で Red Hat Advanced Cluster Management for Kubernetes を使用している場合、Kubernetes Operator 用のマルチクラスターエンジンはすでにクラスターにインストールされています。

インストール時にネットワークから直接パッケージにアクセスするのではなく、パッケージをダウンロードしておき、インストール時にアクセスできるようにする必要があります。

1.2.2.1. 前提条件

Kubernetes Operator 用のマルチクラスターエンジンをインストールする前に、次の要件を満たしている必要があります。

- お使いの環境に Red Hat OpenShift Container Platform バージョン 4.8 以降をインストールし、コマンドラインインターフェイス (CLI) でログインしている。

catalog.redhat.com にアクセスできる。

注記: ベアメタルクラスターを管理する場合は、Red Hat OpenShift Container Platform バージョン 4.8 以降が必要です。

OpenShift Container Platform version 4.10、OpenShift Container Platform version 4.8 を参照してください。

-

Red Hat OpenShift Container Platform の CLI バージョンは 4.8 以降を使用し、

ocコマンドを実行できるように設定している。Red Hat OpenShift CLI のインストールおよび設定の詳細は、CLI の使用方法 を参照してください。 - namespace の作成が可能な Red Hat OpenShift Container Platform の権限を設定している。

- Operator の依存関係をダウンロードするために、インターネット接続のあるワークステーションが必要。

1.2.2.2. OpenShift Container Platform インストールの確認

- レジストリー、ストレージサービスなど、サポート対象の OpenShift Container Platform バージョンがクラスターにインストールされ、機能する状態である必要があります。OpenShift Container Platform バージョン 4.8 の詳細は、OpenShift Container Platform documentation を参照してください。

接続されている場合は、以下のコマンドを使用して OpenShift Container Platform Web コンソールにアクセスすることにより、OpenShift Container Platform クラスターが正しく設定されていることを確認できます。

kubectl -n openshift-console get route console

kubectl -n openshift-console get route consoleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の出力例を参照してください。

console console-openshift-console.apps.new-coral.purple-chesterfield.com console https reencrypt/Redirect None

console console-openshift-console.apps.new-coral.purple-chesterfield.com console https reencrypt/Redirect NoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow この例のコンソール URL は

https:// console-openshift-console.apps.new-coral.purple-chesterfield.comです。ブラウザーで URL を開き、結果を確認します。コンソール URL の表示が

console-openshift-console.router.default.svc.cluster.localの場合は、Red Hat OpenShift Container Platform のインストール時にopenshift_master_default_subdomainを設定します。

1.2.2.3. 非接続環境でのインストール

重要: 必要なイメージをミラーリングレジストリーにダウンロードし、非接続環境で Operator をインストールする必要があります。ダウンロードがないと、デプロイメント時に ImagePullBackOff エラーが表示される可能性があります。

次の手順に従って、切断された環境に Kubernetes Operator 用のマルチクラスターエンジンをインストールします。

ミラーレジストリーを作成します。ミラーレジストリーがまだない場合は、Red Hat OpenShift Container Platform ドキュメントの 非接続インストールのミラーリング の手順を実行してミラーレジストリーを作成してください。

ミラーレジストリーがすでにある場合は、既存のレジストリーを設定して使用できます。

注記: ベアメタルの場合のみ、

install-config.yamlファイルに、接続なしのレジストリーの証明書情報を指定する必要があります。保護された切断されたレジストリー内のイメージにアクセスするには、Kubernetes Operator のマルチクラスターエンジンがレジストリーにアクセスできるように、証明書情報を提供する必要があります。- レジストリーから証明書情報をコピーします。

-

エディターで

install-config.yamlファイルを開きます。 -

additionalTrustBundle: |のエントリーを検索します。 additionalTrustBundleの行の後に証明書情報を追加します。追加後の内容は以下の例のようになります。additionalTrustBundle: | -----BEGIN CERTIFICATE----- certificate_content -----END CERTIFICATE----- sshKey: >-

additionalTrustBundle: | -----BEGIN CERTIFICATE----- certificate_content -----END CERTIFICATE----- sshKey: >-Copy to Clipboard Copied! Toggle word wrap Toggle overflow

重要: 以下のガバナンスポリシーが必要な場合は、非接続イメージレジストリーの追加ミラーが必要です。

-

Container Security Operator ポリシー: イメージはソース

registry.redhat.io/quayにあります。 -

Compliance Operator ポリシー: イメージはソース

registry.redhat.io/complianceにあります。 非推奨 Gatekeeper Operator ポリシー: イメージはソース

registry.redhat.io/rhacm2にあります。Gatekeeper Operator は、Gatekeeper コミュニティーの取り組みおよびリリースに合わせて非推奨になりました。代わりにサブスクリプションでインストールしてください。

3 つのすべての Operator については、以下のミラー一覧を参照してください。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

Container Security Operator ポリシー: イメージはソース

-

install-config.yamlファイルを保存します。 mce-policy.yamlという名前のImageContentSourcePolicyを含む YAML ファイルを作成します。注記: 実行中のクラスターでこれを変更すると、すべてのノードのローリング再起動が実行されます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを入力して ImageContentSourcePolicy ファイルを適用します。

oc apply -f mce-policy.yaml

oc apply -f mce-policy.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ネットワーク接続されていない Operator Lifecycle Manager の Red Hat Operator と コミュニティーの Operator を有効にします。

Kubernetes Operator 用のマルチクラスターエンジンは、Operator Lifecycle Manager Red Hat カタログに含まれています。

- Red Hat Operator カタログの非接続 Operator Lifecycle Manager を設定します。Red Hat OpenShift Container Platform ドキュメントの ネットワークが制限された環境での Operator Lifecycle Manager の使用 の手順を実行します。

- 切断された Operator Lifecycle Manager にイメージが作成されたので、引き続き、Operator Lifecycle Manager カタログから Kubernetes 用の Kubernetes Operator 用のマルチクラスターエンジンをインストールします。

必要な手順については、ネットワーク接続時のオンラインインストール を参照してください。

1.2.3. 詳細設定

Kubernetes Operator のマルチクラスターエンジンは、必要なすべてのコンポーネントをデプロイする Operator を使用してインストールされます。Kubernetes Operator のマルチクラスターエンジンは、インストール中またはインストール後に、MultiClusterEngine カスタムリソースに次の属性の 1 つ以上を追加することでさらに設定できます。

1.2.3.1. ローカルクラスターの有効化

マネージド ハブクラスターの名前は local-cluster です。ハブクラスターがそれ自体を管理するようにする場合は、spec. disableHubSelfManagement の設定を true に変更して、既存のクラスターを local-cluster としてインポートする必要があります。

この設定が、カスタムリソースを定義する YAML ファイルに含まれていない場合は、これを追加する必要があります。ハブクラスターは、このオプションでのみ管理できます。

使用するデフォルトのテンプレートの次の例のような

import-hub.yamlという名前の YAML ファイルを作成します。namespaceはお使いのプロジェクト名に置き換えます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、ファイルを適用します。

oc apply -f import-hub.yaml

oc apply -f import-hub.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

自己管理されるハブクラスターは、クラスターの一覧で local-cluster として指定されます。

1.2.3.2. カスタムイメージプルシークレット

OpenShift Container Platform または Kubernetes Operator 用のマルチクラスターエンジンによって作成されていない Kubernetes クラスターをインポートする場合は、OpenShift Container Platform プルシークレット情報を含むシークレットを生成して、ディストリビューションレジストリーから資格のあるコンテンツにアクセスします。

OpenShift Container Platform クラスターのシークレット要件は、OpenShift Container Platform および multicluster engine for Kubernetes により自動で解決されるため、他のタイプの Kubernetes クラスターをインポートして管理しない場合には、このシークレットを作成する必要はありません。

重要: これらのシークレットは namespace に依存するため、エンジンに使用する namespace にいることを確認してください。

- cloud.redhat.com/openshift/install/pull-secret から Download pull secret を選択して、OpenShift Container Platform のプルシークレットファイルをダウンロードします。OpenShift Container Platform プルシークレットは Red Hat カスタマーポータル ID に関連しており、すべての Kubernetes プロバイダーで同じです。

以下のコマンドを実行してシークレットを作成します。

oc create secret generic <secret> -n <namespace> --from-file=.dockerconfigjson=<path-to-pull-secret> --type=kubernetes.io/dockerconfigjson

oc create secret generic <secret> -n <namespace> --from-file=.dockerconfigjson=<path-to-pull-secret> --type=kubernetes.io/dockerconfigjsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

secretは作成するシークレット名に置き換えます。 -

シークレットは namespace 固有であるため、

namespaceはプロジェクトの namespace に置き換えます。 -

path-to-pull-secretはダウンロードした OpenShift Container Platform のプルシークレットへのパスに置き換えます。

-

以下の例では、カスタムプルシークレットを使用する場合に使用する spec.imagePullSecret テンプレートを表示しています。secret は、プルシークレット名に置き換えます。

1.2.3.3. ターゲット namespace

MultiClusterEngine カスタムリソースで場所を指定することにより、指定された namespace にオペランドをインストールできます。この namespace は、MultiClusterEngine カスタムリソースの適用時に作成されます。

重要: ターゲット namespace が指定されていない場合、Operator は multicluster-engine namespace にインストールし、MultiClusterEngine カスタムリソース仕様で設定します。

次の例は、ターゲット namespace を指定するために使用できる spec.targetNamespace テンプレートを示しています。target を宛先 namespace の名前に置き換えます。注記: target namespace を default namespace にすることはできません。

1.2.3.4. availabilityConfig

ハブクラスターには、High と Basic の 2 つの可用性があります。デフォルトでは、ハブクラスターには High の可用性があります。これにより、ハブクラスターコンポーネントに replicaCount 2 が提供されます。これにより、フェイルオーバー時のサポートが向上しますが、Basic 可用性よりも多くのリソースを消費します。これにより、コンポーネントには replicaCount 1 が提供されます。

以下の例は、Basic の可用性のある spec.availabilityConfig テンプレートを示しています。

1.2.3.5. nodeSelector

MultiClusterEngine でノードセレクターのセットを定義して、クラスター上の特定のノードにインストールできます。次の例は、ラベル node-role.kubernetes.io/infra を持つノードに Pod を割り当てる spec.nodeSelector を示しています。

spec:

nodeSelector:

node-role.kubernetes.io/infra: ""

spec:

nodeSelector:

node-role.kubernetes.io/infra: ""1.2.3.6. Toleration

許容範囲のリストを定義して、MultiClusterEngine がクラスターで定義された特定の taint を許容できるようにすることができます。以下の例は、node-role.kubernetes.io/infra Taint に一致する spec.tolerations を示しています。

spec:

tolerations:

- key: node-role.kubernetes.io/infra

effect: NoSchedule

operator: Exists

spec:

tolerations:

- key: node-role.kubernetes.io/infra

effect: NoSchedule

operator: Exists以前の infra-node Toleration は、設定に Toleration を指定せずにデフォルトで Pod に設定されます。設定で許容値をカスタマイズすると、このデフォルトの動作が置き換えられます。

1.2.3.7. ManagedServiceAccount アドオン (テクノロジープレビュー)

デフォルトでは、Managed-ServiceAccount アドオンは無効になっています。このコンポーネントを有効にすると、マネージドクラスターでサービスアカウントを作成または削除できます。このアドオンを有効にしてインストールするには、spec.overrides の MultiClusterEngine 仕様に以下を含めます。

Managed-ServiceAccount アドオンは、MultiClusterEngine の作成後に、コマンドラインでリソースを編集し、managedserviceaccount-preview コンポーネントを enabled: true に設定することで有効にできます。または、次のコマンドを実行して、<multiclusterengine-name> を MultiClusterEngine リソースの名前に置き換えることもできます。

oc patch MultiClusterEngine <multiclusterengine-name> --type=json -p='[{"op": "add", "path": "/spec/overrides/components/-","value":{"name":"managedserviceaccount-preview","enabled":true}}]'

oc patch MultiClusterEngine <multiclusterengine-name> --type=json -p='[{"op": "add", "path": "/spec/overrides/components/-","value":{"name":"managedserviceaccount-preview","enabled":true}}]'1.2.3.8. hypershift アドオン (テクノロジープレビュー)

デフォルトでは、Hypershift アドオンは無効になっています。このアドオンを有効にしてインストールするには、spec.overrides の MultiClusterEngine 値に以下を含めます。

Hypershift アドオンは、MultiClusterEngine の作成後に、コマンドラインでリソースを編集し、hypershift-preview コンポーネントを enabled: true に設定することで有効にできます。または、次のコマンドを実行して、<multiclusterengine-name> を MultiClusterEngine リソースの名前に置き換えることもできます。

oc patch MultiClusterEngine <multiclusterengine-name> --type=json -p='[{"op": "add", "path": "/spec/overrides/components/-","value":{"name":"hypershift-preview","enabled":true}}]'

oc patch MultiClusterEngine <multiclusterengine-name> --type=json -p='[{"op": "add", "path": "/spec/overrides/components/-","value":{"name":"hypershift-preview","enabled":true}}]'1.2.4. アンインストール

Kubernetes のマルチクラスターエンジンをアンインストールすると、プロセスの 2 つの異なるレベルが表示されます。custom resource removal と complete operator uninstall です。アンインストールプロセスの完了に最長 5 分かかる可能性があります。

-

カスタムリソースの削除は、最も基本的なアンインストールの種類で、

MultiClusterEngineインスタンスのカスタムリソースを削除しますが、他の必要なコンポーネントが残されたままになります。このレベルのアンインストールは、同じ設定とコンポーネントを使用して再インストールする予定の場合に役立ちます。 - 2 番目のレベルは、より完全なアンインストールで、カスタムリソース定義などのコンポーネントを除き、ほとんどの Operator コンポーネントを削除します。この手順を続行すると、カスタムリソースの削除で削除されていないコンポーネントおよびサブスクリプションがすべて削除されます。アンインストールが済むと、カスタムリソースの前に Operator を再インストールする必要があります。

1.2.4.1. 前提条件: 有効化されたサービスのデタッチ

Kubernetes エンジンのマルチクラスターエンジンをアンインストールする前に、そのエンジンによって管理されているすべてのクラスターをデタッチする必要があります。エラーを回避するには、エンジンによって管理されているすべてのクラスターをデタッチしてから、アンインストールを再試行してください。

マネージドクラスターがアタッチされている場合は、以下のメッセージが表示される可能性があります。

Cannot delete MultiClusterEngine resource because ManagedCluster resource(s) exist

Cannot delete MultiClusterEngine resource because ManagedCluster resource(s) existCopy to Clipboard Copied! Toggle word wrap Toggle overflow クラスターのデタッチの詳細は、クラスターの作成 でお使いのプロバイダーの情報を選択して、マネージメントからのクラスターの削除 セクションを参照してください。

1.2.4.2. コマンドを使用したリソースの削除

-

まだの場合には、

ocコマンドが実行できるように、OpenShift Container Platform CLI が設定されていることを確認してください。ocコマンドの設定方法は、Red Hat OpenShift Container Platform ドキュメントの OpenShift CLI の使用方法 を参照してください。 以下のコマンドを入力してプロジェクトの namespace に移動します。namespace はお使いのプロジェクトの namespace 名に置き換えます。

oc project <namespace>

oc project <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、

MultiClusterEngineカスタムリソースを削除します。oc delete multiclusterengine --all

oc delete multiclusterengine --allCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを入力して進捗を表示できます。

oc get multiclusterengine -o yaml

oc get multiclusterengine -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

以下のコマンドを入力し、インストールされている namespace の multicluster-engine

ClusterServiceVersionを削除します。

ここに表示されている CSV バージョンは異なる場合があります。

1.2.4.3. コンソールを使用したコンポーネントの削除

Red Hat OpenShift Container Platform コンソールを使用してアンインストールする場合に、operator を削除します。コンソールを使用してアンインストールを行うには、以下の手順を実行します。

- OpenShift Container Platform コンソールナビゲーションで、Operators > Installed Operators > multicluster engine for Kubernetes を選択します。

MultiClusterEngineカスタムリソースを削除します。- Multiclusterengine のタブを選択します。

- MultiClusterEngine カスタムリソースの Options メニューを選択します。

- Delete MultiClusterEngine を選択します。

次のセクションの手順に従って、クリーンアップスクリプトを実行します。

ヒント: Kubernetes バージョンで同じマルチクラスターエンジンを再インストールする場合は、この手順の残りの手順をスキップして、カスタムリソースを再インストールできます。

- Installed Operators に移動します。

- Options メニューから Uninstall operator を選択して、_ multicluster engine for Kubernetes_ Operator を削除してください。

1.2.4.4. トラブルシューティングアンインストール

マルチクラスターエンジンのカスタムリソースが削除されていない場合は、クリーンアップスクリプトを実行して、残っている可能性のあるアーティファクトをすべて削除します。

以下のスクリプトをファイルにコピーします。

#!/bin/bash oc delete apiservice v1.admission.cluster.open-cluster-management.io v1.admission.work.open-cluster-management.io oc delete validatingwebhookconfiguration multiclusterengines.multicluster.openshift.io oc delete mce --all

#!/bin/bash oc delete apiservice v1.admission.cluster.open-cluster-management.io v1.admission.work.open-cluster-management.io oc delete validatingwebhookconfiguration multiclusterengines.multicluster.openshift.io oc delete mce --allCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.3. 認証情報の管理

クラスターの認証情報を作成して管理できます。Kubernetes Operator 用のマルチクラスターエンジンを備えたクラウドサービスプロバイダーで Red Hat OpenShift Container Platform クラスターを作成するには、認証情報 が必要です。認証情報では、クラウドプロバイダーのアクセス情報を保存します。1 つのプロバイダーのドメインごとに独自の認証情報が必要になるのと同様に、プロバイダーアカウントごとに独自の認証情報が必要です。

認証情報は Kubernetes Secret として保存されます。シークレットはマネージドクラスターの namespace にコピーされ、マネージドクラスターのコントローラーがシークレットにアクセスできるようになります。認証情報が更新されると、シークレットのコピーはマネージドクラスターの namespace で自動的に更新されます。

注記: 元の認証情報を使用してすでにプロビジョニングされているため、クラウドプロバイダーの認証情報のプルシークレットまたは SSH キーへの変更は、既存のマネージドクラスターに反映されません。

必要なアクセス権限: 編集

1.3.1. Amazon Web Services の認証情報の作成

Amazon Web Services (AWS) で Red Hat OpenShift Container Platform クラスターをデプロイおよび管理するには、Kubernetes Operator コンソール用のマルチクラスターエンジンを使用するための認証情報が必要です。

必要なアクセス権限: 編集

注意: この手順は、Kubernetes Operator 用のマルチクラスターエンジンを使用してクラスターを作成する前に実行する必要があります。

1.3.1.1. 前提条件

認証情報を作成する前に、以下の前提条件を満たす必要があります。

- Kubernetes Operator ハブクラスター用にデプロイされたマルチクラスターエンジン

- Amazon Web Services (AWS) で Kubernetes クラスターを作成できるように、Kubernetes Operator ハブクラスター用のマルチクラスターエンジンのインターネットアクセス

- アクセスキー ID およびシークレットアクセスキーなど、AWS のログイン認証情報。Understanding and getting your AWS credentials を参照してください。

- AWS でクラスターをインストールできるようにするアカウントの権限。設定の方法は、AWS アカウントの設定 を参照してください。

1.3.1.2. コンソールを使用した認証情報の管理

Kubernetes Operator コンソール用のマルチクラスターエンジンから認証情報を作成するには、コンソールで手順を実行します。

ナビゲーションメニューから開始します。Credentials をクリックし、既存の認証情報オプションから選択します。ヒント: 便宜上およびセキュリティー上、認証情報のホスト専用の namespace を作成します。

オプションで、認証情報の ベース DNS ドメイン を追加できます。ベース DNS ドメインを認証情報に追加した場合は、この認証情報でクラスターを作成すると、このベース DNS ドメインは自動的に正しいフィールドに設定されます。以下の手順を参照してください。

- AWS アカウントの AWS アクセスキー ID を追加します。AWS にログインして ID を見つけます。

- 新しい AWS Secret Access Key の内容を提供します。

プロキシーを有効にする必要がある場合は、プロキシー情報を入力します。

-

HTTP プロキシー URL:

HTTPトラフィックのプロキシーとして使用する URL。 -

HTTPS プロキシー URL:

HTTPSトラフィックに使用するセキュアなプロキシー URL。値の指定がない場合は、HTTP Proxy URLと同じ値がHTTPおよびHTTPSの両方に使用されます。 -

プロキシードメインなし: プロキシーをバイパスする必要のあるドメインのコンマ区切りリスト。ドメイン名をピリオド (

.) で開始し、そのドメインにあるすべてのサブドメインを組み込みます。アステリスク (*) を追加し、すべての宛先のプロキシーをバイパスします。 - 追加のトランスとバンドル: ミラーレジストリーへのアクセスに必要な証明書ファイルのコンテンツ。

-

HTTP プロキシー URL:

- Red Hat OpenShift pull secret を入力します。Pull secret からプルシークレットをダウンロードします。

- SSH 秘密鍵 と SSH 公開鍵 を追加し、クラスターに接続できるようにします。既存のキーペアを使用するか、キー生成プログラムで新しいキーを作成できます。

キー生成の方法は、SSH プライベートキーの生成およびエージェントへの追加 を参照してください。

Amazon Web Services でのクラスターの作成 の手順を完了することで、この認証情報を使用するクラスターを作成できます。

コンソールで認証情報を編集できます。このプロバイダー接続を使用してクラスターが作成された場合には、<cluster-namespace> からの <cluster-name>-aws-creds> シークレットが新規の認証情報に更新されます。

注記: クラスタープールが要求したクラスターでは、認証情報は更新されません。

認証情報を使用するクラスターの管理を終了する場合は、認証情報を削除して認証情報内にある情報を保護します。Actions を選択して、一括削除するか、削除する認証情報の横にあるオプションメニューを選択します。

1.3.1.3. API を使用した不透明なシークレットの作成

API を使用して Amazon Web Services の不透明なシークレットを作成するには、次の例のような YAML プレビューウィンドウで YAML コンテンツを適用します。

注記: 不透明なシークレットは、選択したマネージドクラスターの namespace に作成されます。Hive は不透明なシークレットを使用してクラスターをプロビジョニングします。Red Hat Advanced Cluster Management コンソールを使用してクラスターをプロビジョニングすると、事前に作成された認証情報は、不透明なシークレットとしてマネージドクラスターの namespace にコピーされます。

1.3.2. Microsoft Azure の認証情報の作成

Microsoft Azure または Microsoft Azure Government で Red Hat OpenShift Container Platform クラスターを作成および管理するには、Kubernetes Operator コンソール用のマルチクラスターエンジンを使用するための認証情報が必要です。

必要なアクセス権限: 編集

注意: この手順は、Kubernetes Operator 用のマルチクラスターエンジンを使用してクラスターを作成するための前提条件です。

1.3.2.1. 前提条件

認証情報を作成する前に、以下の前提条件を満たす必要があります。

- Kubernetes Operator ハブクラスター用にデプロイされたマルチクラスターエンジン。

- Azure 上に Kubernetes クラスターを作成できるようにする Kubernetes Operator ハブクラスター用のマルチクラスターエンジンのインターネットアクセス。

- ベースドメインのリソースグループおよび Azure Service Principal JSON などの Azure ログイン認証情報。azure.microsoft.com を参照してください。

- Azre でクラスターがインストールできるようにするアカウントの権限。詳細は、How to configure Cloud Services および Azure アカウントの設定 を参照してください。

1.3.2.2. コンソールを使用した認証情報の管理

Kubernetes Operator コンソール用のマルチクラスターエンジンから認証情報を作成するには、コンソールで手順を実行します。ナビゲーションメニューから開始します。Credentials をクリックし、既存の認証情報オプションから選択します。ヒント: 便宜上およびセキュリティー上、認証情報のホスト専用の namespace を作成します。

- オプション: 認証情報の ベース DNS ドメイン を追加します。ベース DNS ドメインを認証情報に追加した場合は、この認証情報でクラスターを作成すると、このベース DNS ドメインは自動的に正しいフィールドに設定されます。

-

クラスターの環境が

AzurePublicCloudまたは、AzureUSGovernmentCloudであるかを選択します。この設定は Azure Government 環境とは異なるため、これが正しく設定されていることを確認します。 - Azure アカウントの ベースドメインリソースグループ名 を追加します。このエントリーは、Azure アカウントで作成したリソース名です。Azure インターフェイスで Home > DNS Zones を選択することで、ベースドメインのリソースグループ名を検索できます。ベースドメインリソースグループ名を見つけるには、Create an Azure service principal with the Azure CLI を参照してください。

クライアント ID の内容を入力します。この値は、以下のコマンドを使用してサービスプリンシパルを作成すると、

appIdプロパティーとして設定されます。az ad sp create-for-rbac --role Contributor --name <service_principal> --scopes <subscription_path>

az ad sp create-for-rbac --role Contributor --name <service_principal> --scopes <subscription_path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow service_principal は、お使いのサービスプリンシパル名に置き換えます。

Client Secret を追加します。この値は、以下のコマンドを使用してサービスプリンシパルを作成すると、

passwordプロパティーとして設定されます。az ad sp create-for-rbac --role Contributor --name <service_principal> --scopes <subscription_path>

az ad sp create-for-rbac --role Contributor --name <service_principal> --scopes <subscription_path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow service_principal は、お使いのサービスプリンシパル名に置き換えます。詳細については、Create an Azure service principal with the Azure CLI を参照してください。

Subscription ID を追加します。以下のコマンドの出力では、この値は、

idプロパティーになります。az account show

az account showCopy to Clipboard Copied! Toggle word wrap Toggle overflow Tenant ID を追加します。以下のコマンドの出力では、この値は、

tenantIdプロパティーになります。az account show

az account showCopy to Clipboard Copied! Toggle word wrap Toggle overflow プロキシーを有効にする場合は、プロキシー情報を入力します。

-

HTTP プロキシー URL:

HTTPトラフィックのプロキシーとして使用する URL。 -

HTTPS プロキシー URL:

HTTPSトラフィックに使用するセキュアなプロキシー URL。値の指定がない場合は、HTTP Proxy URLと同じ値がHTTPおよびHTTPSの両方に使用されます。 -

プロキシードメインなし: プロキシーをバイパスする必要のあるドメインのコンマ区切りリスト。ドメイン名をピリオド (

.) で開始し、そのドメインにあるすべてのサブドメインを組み込みます。アステリスク (*) を追加し、すべての宛先のプロキシーをバイパスします。 - 追加のトランスとバンドル: ミラーレジストリーへのアクセスに必要な証明書ファイルのコンテンツ。

-

HTTP プロキシー URL:

- Red Hat OpenShift pull secret を入力します。Pull secret からプルシークレットをダウンロードします。

- クラスターへの接続に使用する SSH 秘密鍵 と SSH 公開鍵 を追加します。既存のキーペアを使用するか、キー生成プログラムで新しいキーを作成できます。キー生成の方法は、SSH プライベートキーの生成およびエージェントへの追加 を参照してください。

Microsoft Azure でのクラスターの作成 の手順を実行して、この認証情報を使用するクラスターを作成します。

コンソールで認証情報を編集できます。

認証情報を使用するクラスターの管理を終了する場合は、認証情報を削除して認証情報内にある情報を保護します。Actions を選択して、一括削除するか、削除する認証情報の横にあるオプションメニューを選択します。

1.3.2.3. API を使用した不透明なシークレットの作成

コンソールの代わりに API を使用して Microsoft Azure の不透明なシークレットを作成するには、次の例のような YAML プレビューウィンドウで YAML コンテンツを適用します。

注記: 不透明なシークレットは、選択したマネージドクラスターの namespace に作成されます。Hive は不透明なシークレットを使用してクラスターをプロビジョニングします。Red Hat Advanced Cluster Management コンソールを使用してクラスターをプロビジョニングすると、事前に作成された認証情報は、不透明なシークレットとしてマネージドクラスターの namespace にコピーされます。

1.3.3. Google Cloud Platform の認証情報の作成

Google Cloud Platform (GCP) で Red Hat OpenShift Container Platform クラスターを作成および管理するには、Kubernetes Operator コンソール用のマルチクラスターエンジンを使用するための認証情報が必要です。

必要なアクセス権限: 編集

注意: この手順は、Kubernetes Operator 用のマルチクラスターエンジンを使用してクラスターを作成するための前提条件です。

1.3.3.1. 前提条件

認証情報を作成する前に、以下の前提条件を満たす必要があります。

- Kubernetes Operator ハブクラスター用にデプロイされたマルチクラスターエンジン

- GCP 上に Kubernetes クラスターを作成できるように、Kubernetes Operator ハブクラスター用のマルチクラスターエンジンのインターネットアクセス

- ユーザーの Google Cloud Platform プロジェクト ID および Google Cloud Platform サービスアカウント JSON キーなど、GCP ログインの認証情報。Creating and managing projects を参照してください。

- GCP でクラスターがインストールできるようにするアカウントの権限。アカウントの設定方法は、GCP プロジェクトの設定 を参照してください。

1.3.3.2. コンソールを使用した認証情報の管理

Kubernetes Operator コンソール用のマルチクラスターエンジンから認証情報を作成するには、コンソールで手順を実行します。

ナビゲーションメニューから開始します。Credentials をクリックし、既存の認証情報オプションから選択します。ヒント: 便宜上およびセキュリティー上、認証情報のホスト専用の namespace を作成します。

オプションで、認証情報の ベース DNS ドメイン を追加できます。ベース DNS ドメインを認証情報に追加した場合は、この認証情報でクラスターを作成すると、このベース DNS ドメインは自動的に正しいフィールドに設定されます。以下の手順を参照してください。

- GCP アカウントの Google Cloud Platform project ID を追加します。GCP にログインして設定を取得します。

- Google Cloud Platform service account JSON key を追加します。https://cloud.google.com/iam/docs/creating-managing-service-accounts を参照して、サービスアカウントの JSON キーを作成してください。GCP コンソールの手順に従います。

- 新しい Google Cloud Platform サービスアカウントの JSON キー の内容を提供します。

プロキシーを有効にする場合は、プロキシー情報を入力します。

-

HTTP プロキシー URL:

HTTPトラフィックのプロキシーとして使用する URL。 -

HTTPS プロキシー URL:

HTTPSトラフィックに使用するセキュアなプロキシー URL。値の指定がない場合は、HTTP Proxy URLと同じ値がHTTPおよびHTTPSの両方に使用されます。 -

プロキシードメインなし: プロキシーをバイパスする必要のあるドメインのコンマ区切りリスト。ドメイン名をピリオド (

.) で開始し、そのドメインにあるすべてのサブドメインを組み込みます。アステリスク (*) を追加し、すべての宛先のプロキシーをバイパスします。 - 追加のトランスとバンドル: ミラーレジストリーへのアクセスに必要な証明書ファイルのコンテンツ。

-

HTTP プロキシー URL:

- Red Hat OpenShift pull secret を入力します。Pull secret からプルシークレットをダウンロードします。

- クラスターにアクセスできるように SSH 秘密鍵 と SSH 公開鍵 を追加します。既存のキーペアを使用するか、キー生成プログラムで新しいキーを作成できます。

キー生成の方法は、SSH プライベートキーの生成およびエージェントへの追加 を参照してください。

Google Cloud Platform でのクラスターの作成 の手順を実行することで、クラスターの作成時にこの接続を使用できます。

コンソールで認証情報を編集できます。

認証情報を使用するクラスターの管理を終了する場合は、認証情報を削除して認証情報内にある情報を保護します。Actions を選択して、一括削除するか、削除する認証情報の横にあるオプションメニューを選択します。

1.3.3.3. API を使用した不透明なシークレットの作成

コンソールの代わりに API を使用して Google Cloud Platform の不透明なシークレットを作成するには、次の例のような YAML プレビューウィンドウで YAML コンテンツを適用します。

注記: 不透明なシークレットは、選択したマネージドクラスターの namespace に作成されます。Hive は不透明なシークレットを使用してクラスターをプロビジョニングします。Red Hat Advanced Cluster Management コンソールを使用してクラスターをプロビジョニングすると、事前に作成された認証情報は、不透明なシークレットとしてマネージドクラスターの namespace にコピーされます。

1.3.4. VMware vSphere の認証情報の作成

VMware vSphere で Red Hat OpenShift Container Platform クラスターをデプロイおよび管理するには、Kubernetes Operator コンソール用のマルチクラスターエンジンを使用するための認証情報が必要です。OpenShift Container Platform バージョン 4.5.x 以降のみがサポートされます。

必要なアクセス権限: 編集

注意: この手順は、Kubernetes Operator 用のマルチクラスターエンジンを使用してクラスターを作成する前に実行する必要があります。

1.3.4.1. 前提条件

認証情報を作成する前に、以下の前提条件を満たす必要があります。

- OpenShift Container Platform バージョン 4.6 以降にデプロイされたハブクラスター。

- VMware vSphere に Kubernetes クラスターを作成できるようにするハブクラスターのインターネットアクセス。

インストーラーでプロビジョニングされるインフラストラクチャーを使用する場合に OpenShift Container Platform 向けに設定された VMware vSphere ログイン認証情報および vCenter 要件。カスタマイズによる vSphere へのクラスターのインストール を参照してください。これらの認証除法には、以下の情報が含まれます。

- vCenter アカウントの権限

- クラスターリソース

- HDCP が利用できる

- 時間を同期した ESXi ホスト (例: NTP)

1.3.4.2. コンソールを使用した認証情報の管理

Kubernetes Operator コンソール用のマルチクラスターエンジンから認証情報を作成するには、コンソールで手順を実行します。

ナビゲーションメニューから開始します。Credentials をクリックし、既存の認証情報オプションから選択します。ヒント: 便宜上およびセキュリティー上、認証情報のホスト専用の namespace を作成します。

オプションで、認証情報の ベース DNS ドメイン を追加できます。ベース DNS ドメインを認証情報に追加した場合は、この認証情報でクラスターを作成すると、このベース DNS ドメインは自動的に正しいフィールドに設定されます。以下の手順を参照してください。

- VMware vCenter サーバーの完全修飾ホスト名または IP アドレス を追加します。値は vCenter サーバーのルート CA 証明書に定義する必要があります。可能な場合は、完全修飾ホスト名を使用します。

- VMware vCenter のユーザー名 を追加します。

- VMware vCenter パスワード を追加します。

VMware vCenter ルート CA 証明書 を追加します。

-

VMware vCenter サーバー (

https://<vCenter_address>/certs/download.zip) からdownload.zipとして証明書をダウンロードできます。vCenter_address は、vCenter サーバーのアドレスに置き換えます。 -

download.zipのパッケージを展開します。 拡張子が

.0のcerts/<platform>ディレクトリーの証明書を使用します。ヒント:ls certs/<platform>コマンドを使用して、お使いのプラットフォームで使用可能な全証明書を一覧表示できます。<platform>は、lin、mac、またはwinなど、お使いのプラットフォームに置き換えます。例:

certs/lin/3a343545.0ベストプラクティス: 次のコマンドを使用して、拡張子が

.0の複数の証明書をリンクします。cat certs/lin/*.0 > ca.crt

cat certs/lin/*.0 > ca.crtCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

VMware vCenter サーバー (

- VMware vSphere クラスター名 を追加します。

- VMware vSphere データセンター を追加します。

- VMware vSphere デフォルトデータストア を追加します。

オフラインインストールのみ: Configuration for disconnected installation サブセクションのフィールドに必要な情報を入力します。

Image content source: この値には、オフラインのレジストリーパスが含まれます。このパスには、オフラインインストールに使用する全インストールイメージのホスト名、ポート、レジストリーパスが含まれます。たとえば、

repository.com:5000/openshift/ocp-releaseとなります。このパスは、Red Hat OpenShift Container Platform リリースイメージに対して、

install-config.yamlのイメージコンテンツソースポリシーのマッピングを作成します。たとえば、repository.com:5000は以下のimageContentSourceコンテンツを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow Additional trust bundle: この値で、ミラーレジストリーへのアクセスに必要な証明書ファイルのコンテンツを指定します。

注記: 非接続環境にあるハブクラスターからマネージドクラスターをデプロイして、インストール後の設定を自動的にインポートする場合は、

YAMLエディターを使用してイメージコンテンツソースポリシーをinstall-config.yamlファイルに追加します。エントリーの例を以下に示します。imageContentSources: - mirrors: - registry.example.com:5000/rhacm2 source: registry.redhat.io/rhacm2

imageContentSources: - mirrors: - registry.example.com:5000/rhacm2 source: registry.redhat.io/rhacm2Copy to Clipboard Copied! Toggle word wrap Toggle overflow

プロキシーを有効にする場合は、プロキシー情報を入力します。

-

HTTP プロキシー URL:

HTTPトラフィックのプロキシーとして使用する URL。 -

HTTPS プロキシー URL:

HTTPSトラフィックに使用するセキュアなプロキシー URL。値の指定がない場合は、HTTP Proxy URLと同じ値がHTTPおよびHTTPSの両方に使用されます。 -

プロキシードメインなし: プロキシーをバイパスする必要のあるドメインのコンマ区切りリスト。ドメイン名をピリオド (

.) で開始し、そのドメインにあるすべてのサブドメインを組み込みます。アステリスク (*) を追加し、すべての宛先のプロキシーをバイパスします。 - 追加のトランスとバンドル: ミラーレジストリーへのアクセスに必要な証明書ファイルのコンテンツ。

-

HTTP プロキシー URL:

- Red Hat OpenShift pull secret を入力します。Pull secret からプルシークレットをダウンロードします。

SSH 秘密鍵 と SSH 公開鍵 を追加し、クラスターに接続できるようにします。

既存のキーペアを使用するか、キー生成プログラムで新しいキーを作成できます。詳細は、クラスターノードの SSH アクセス用のキーペアの生成 を参照してください。

VMware vSphere でのクラスターの作成 の手順を完了することで、この認証情報を使用するクラスターを作成できます。

コンソールで認証情報を編集できます。

認証情報を使用するクラスターの管理を終了する場合は、認証情報を削除して認証情報内にある情報を保護します。Actions を選択して、一括削除するか、削除する認証情報の横にあるオプションメニューを選択します。

1.3.4.3. API を使用した不透明なシークレットの作成

コンソールの代わりに API を使用して VMware vSphere の不透明なシークレットを作成するには、次の例のような YAML プレビューウィンドウで YAML コンテンツを適用します。

注記: 不透明なシークレットは、選択したマネージドクラスターの namespace に作成されます。Hive は不透明なシークレットを使用してクラスターをプロビジョニングします。Red Hat Advanced Cluster Management コンソールを使用してクラスターをプロビジョニングすると、事前に作成された認証情報は、不透明なシークレットとしてマネージドクラスターの namespace にコピーされます。

1.3.5. Red Hat OpenStack の認証情報の作成

Red Hat OpenStack Platform で Red Hat OpenShift Container Platform クラスターをデプロイおよび管理するには、Kubernetes Operator コンソール用のマルチクラスターエンジンを使用するための認証情報が必要です。OpenShift Container Platform バージョン 4.5.x 以降のみがサポートされます。

注記: この手順は、Kubernetes Operator 用のマルチクラスターエンジンでクラスターを作成する前に、実行する必要があります。

1.3.5.1. 前提条件

認証情報を作成する前に、以下の前提条件を満たす必要があります。

- OpenShift Container Platform バージョン 4.6 以降にデプロイされたハブクラスター。

- Red Hat OpenStack Platform で Kubernetes クラスターを作成できるようにするハブクラスターのインターネットアクセス。

- インストーラーでプロビジョニングされるインフラストラクチャーを使用する場合に OpenShift Container Platform 向けに設定された Red Hat OpenStack Platform ログイン認証情報および Red Hat OpenStack Platform の要件。カスタマイズによる OpenStack へのクラスターのインストール を参照してください。

CloudStack API にアクセスするための

clouds.yamlファイルをダウンロードまたは作成する。clouds.yamlファイルで以下を行います。- 使用する cloud auth セクション名を決定します。

- username 行の直後に、password の行を追加します。

1.3.5.2. コンソールを使用した認証情報の管理

Kubernetes Operator コンソール用のマルチクラスターエンジンから認証情報を作成するには、コンソールで手順を実行します。

ナビゲーションメニューから開始します。Credentials をクリックし、既存の認証情報オプションから選択します。ヒント: 便宜上およびセキュリティー向上のため、認証情報のホスト専用の namespace を作成します。

-

Red Hat OpenStack Platform の

clouds.yamlファイルの内容を追加します。パスワードを含むclouds.yamlファイルの内容で、Red Hat OpenStack Platform サーバーへの接続に必要な情報を提供します。ファイルの内容には、usernameの直後に新たに追加したパスワードを含める必要があります。 内部認証局を使用する設定については、

clouds.yamlファイルを変更して、Hive デプロイヤー Pod 内の証明書バンドルの最終場所を参照します。Hive は、証明書バンドルシークレットをデプロイヤー Pod 内の/etc/openstack-caにマウントします。そのディレクトリー内のファイルは、クラスターの作成時に提供されるシークレットのキーに対応します。シークレットでキー

ca.crtが使用されている場合は、以下の例のようにcacertパラメーターをclouds.yamlファイルに追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

Red Hat OpenStack Platform クラウド名を追加します。このエントリーは、Red Hat OpenStack Platform サーバーへの通信確立に使用する

clouds.yamlの cloud セクションで指定した名前です。 - オプションで、認証情報のベース DNS ドメインを追加できます。ベース DNS ドメインを認証情報に追加した場合は、この認証情報でクラスターを作成すると、このベース DNS ドメインは自動的に正しいフィールドに設定されます。

オフラインインストールのみ: Configuration for disconnected installation サブセクションのフィールドに必要な情報を入力します。

- Cluster OS image: この値には、Red Hat OpenShift Container Platform クラスターマシンに使用するイメージの URL が含まれます。

イメージコンテンツソース: この値には、オフラインのレジストリーパスが含まれます。このパスには、オフラインインストールに使用する全インストールイメージのホスト名、ポート、レジストリーパスが含まれます。たとえば、

repository.com:5000/openshift/ocp-releaseとなります。このパスは、Red Hat OpenShift Container Platform リリースイメージに対して、

install-config.yamlのイメージコンテンツソースポリシーのマッピングを作成します。たとえば、repository.com:5000は以下のimageContentSourceコンテンツを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow Additional trust bundle: この値で、ミラーレジストリーへのアクセスに必要な証明書ファイルのコンテンツを指定します。

注記: 非接続環境にあるハブクラスターからマネージドクラスターをデプロイして、インストール後の設定を自動的にインポートする場合は、

YAMLエディターを使用してイメージコンテンツソースポリシーをinstall-config.yamlファイルに追加します。エントリーの例を以下に示します。imageContentSources: - mirrors: - registry.example.com:5000/rhacm2 source: registry.redhat.io/rhacm2

imageContentSources: - mirrors: - registry.example.com:5000/rhacm2 source: registry.redhat.io/rhacm2Copy to Clipboard Copied! Toggle word wrap Toggle overflow

プロキシーを有効にする必要がある場合は、プロキシー情報を入力します。

-

HTTP プロキシー URL:

HTTPトラフィックのプロキシーとして使用する URL。 -

HTTPS プロキシー URL:

HTTPSトラフィックに使用するセキュアなプロキシー URL。値の指定がない場合は、HTTP Proxy URLと同じ値がHTTPおよびHTTPSの両方に使用されます。 -

プロキシードメインなし: プロキシーをバイパスする必要のあるドメインのコンマ区切りリスト。ドメイン名をピリオド (

.) で開始し、そのドメインにあるすべてのサブドメインを組み込みます。アステリスク (*) を追加し、すべての宛先のプロキシーをバイパスします。 - 追加のトランスとバンドル: ミラーレジストリーへのアクセスに必要な証明書ファイルのコンテンツ。

-

HTTP プロキシー URL:

- Red Hat OpenShift プルシークレットを入力します。Pull secret からプルシークレットをダウンロードします。

- SSH 秘密鍵と SSH 公開鍵を追加し、クラスターに接続できるようにします。既存のキーペアを使用するか、キー生成プログラムで新しいキーを作成できます。詳細は、クラスターノードの SSH アクセス用のキーペアの生成 を参照してください。

- Create をクリックします。

- 新規の認証情報を確認し、Add をクリックします。認証情報を追加すると、認証情報のリストに追加されます。

Red Hat OpenStack Platform でのクラスターの作成 の手順を実行して、この認証情報を使用するクラスターを作成します。

コンソールで認証情報を編集できます。

認証情報を使用するクラスターの管理を終了する場合は、認証情報を削除して認証情報内にある情報を保護します。Actions を選択して、一括削除するか、削除する認証情報の横にあるオプションメニューを選択します。

1.3.5.3. API を使用した不透明なシークレットの作成

コンソールの代わりに API を使用して Red Hat OpenStack Platform の不透明なシークレットを作成するには、次の例のような YAML プレビューウィンドウで YAML コンテンツを適用します。

注記: 不透明なシークレットは、選択したマネージドクラスターの namespace に作成されます。Hive は不透明なシークレットを使用してクラスターをプロビジョニングします。Red Hat Advanced Cluster Management コンソールを使用してクラスターをプロビジョニングすると、事前に作成された認証情報は、不透明なシークレットとしてマネージドクラスターの namespace にコピーされます。

1.3.6. Red Hat Virtualization の認証情報の作成

Red Hat Virtualization で Red Hat OpenShift Container Platform クラスターをデプロイおよび管理するには、Kubernetes Operator コンソール用のマルチクラスターエンジンを使用するための認証情報が必要です。

注意: この手順は、Kubernetes Operator 用のマルチクラスターエンジンを使用してクラスターを作成する前に実行する必要があります。

1.3.6.1. 前提条件

認証情報を作成する前に、以下の前提条件を満たす必要があります。

- OpenShift Container Platform バージョン 4.7 以降にデプロイされたハブクラスター。

- Red Hat Virtualization で Kubernetes クラスターを作成できるようにするハブクラスターのインターネットアクセス。

設定済み Red Hat Virtualization 環境の Red Hat Virtualization ログイン認証情報。Red Hat Virtualization ドキュメントの インストールガイド を参照してください。以下のリストは、必要な情報を示しています。

- oVirt URL

- ovirt 完全修飾ドメイン名 (FQDN)

- oVirt ユーザー名

- oVirt パスワード

- oVirt CA/証明書

- オプション: プロキシーを有効にした場合にはプロキシー情報。

- Red Hat OpenShift Container Platform のプルシークレット情報。Pull secret からプルシークレットをダウンロードします。

- 最終的なクラスターの情報を転送するための SSH 秘密鍵と公開鍵。

- oVirt でクラスターをインストールできるようにするアカウントの権限。

1.3.6.2. コンソールを使用した認証情報の管理

Kubernetes Operator コンソール用のマルチクラスターエンジンから認証情報を作成するには、コンソールで手順を実行します。

ナビゲーションメニューから開始します。Credentials をクリックし、既存の認証情報オプションから選択します。ヒント: 便宜上およびセキュリティー向上のため、認証情報のホスト専用の namespace を作成します。

- 新しい認証情報の基本情報を追加します。オプションで、この認証情報を使用してクラスターを作成すると自動的に正しいフィールドにデータが投入される Base DNS ドメインを追加できます。認証情報に追加しない場合は、クラスターの作成時に追加できます。

- Red Hat Virtualization 環境に必要な情報を追加します。

プロキシーを有効にする必要がある場合は、プロキシー情報を入力します。

-

HTTP Proxy URL:

HTTPトラフィックのプロキシーとして使用する URL。 -

HTTPS Proxy URL:

HTTPSトラフィックに使用する必要のあるセキュアなプロキシー URL。値の指定がない場合は、HTTP Proxy URLと同じ値がHTTPおよびHTTPSの両方に使用されます。 -

プロキシードメインなし: プロキシーをバイパスする必要のあるドメインのコンマ区切りリスト。ドメイン名をピリオド (

.) で開始し、そのドメインにあるすべてのサブドメインを組み込みます。アステリスク (*) を追加し、すべての宛先のプロキシーをバイパスします。

-

HTTP Proxy URL:

- Red Hat OpenShift Container Platform プルシークレットを入力します。Pull secret からプルシークレットをダウンロードします。

- SSH 秘密鍵と SSH 公開鍵を追加し、クラスターに接続できるようにします。既存のキーペアを使用するか、キー生成プログラムで新しいキーを作成できます。詳細は、クラスターノードの SSH アクセス用のキーペアの生成 を参照してください。

- 新規の認証情報を確認し、Add をクリックします。認証情報を追加すると、認証情報の一覧に追加されます。

Red Hat Virtualization でのクラスターの作成 の手順を実行して、この認証情報を使用するクラスターを作成します。

コンソールで認証情報を編集できます。

認証情報を使用するクラスターの管理を終了する場合は、認証情報を削除して認証情報内にある情報を保護します。Actions を選択して、一括削除するか、削除する認証情報の横にあるオプションメニューを選択します。

1.3.7. Red Hat OpenShift Cluster Manager の認証情報の作成

クラスターを検出できるように OpenShift Cluster Manager の認証情報を追加します。

必要なアクセス権限: 管理者

1.3.7.1. 前提条件

cloud.redhat.com アカウントへのアクセスが必要です。console.redhat.com/openshift/token から取得できる値が後で必要になります。

1.3.7.2. コンソールを使用した認証情報の管理

クラスター検出用の認証情報を追加する必要があります。Kubernetes Operator コンソール用のマルチクラスターエンジンから認証情報を作成するには、コンソールで手順を実行します。

ナビゲーションメニューから開始します。Credentials をクリックし、既存の認証情報オプションから選択します。ヒント: 便宜上およびセキュリティー上、認証情報のホスト専用の namespace を作成します。

OpenShift Cluster Manager API トークンは、console.redhat.com/openshift/token から取得できます。

コンソールで認証情報を編集できます。

認証情報を使用するクラスターの管理を終了する場合は、認証情報を削除して認証情報内にある情報を保護します。Actions を選択して、一括削除するか、削除する認証情報の横にあるオプションメニューを選択します。

認証情報が削除されるか、OpenShift Cluster Manager API トークンの有効期限が切れるか、取り消されると、関連付けられた検出クラスターが削除されます。

1.3.8. Ansible Automation Platform の認証情報の作成

Red Hat Ansible Automation Platform を使用している Red Hat OpenShift Container Platform クラスターをデプロイおよび管理するには、Kubernetes Operator コンソール用のマルチクラスターエンジンを使用するための認証情報が必要です。

必要なアクセス権限: 編集

注意: この手順は、Ansible ジョブテンプレートを作成してクラスターで自動化を有効にする前に実行する必要があります。

1.3.8.1. 前提条件

認証情報を作成する前に、以下の前提条件を満たす必要があります。

- Kubernetes Operator ハブクラスター用にデプロイされたマルチクラスターエンジン

- Kubernetes Operator ハブクラスター用のマルチクラスターエンジンのインターネットアクセス

- Ansible Tower ホスト名および OAuth トークンを含む Ansible ログイン認証情報。Ansible Tower の認証情報 を参照してください。

- ハブクラスターのインストールおよび Ansible 操作をできるようにするアカウントパーミッション。Ansible ユーザー の詳細を確認してください。

1.3.8.2. コンソールを使用した認証情報の管理

Kubernetes Operator コンソール用のマルチクラスターエンジンから認証情報を作成するには、コンソールで手順を実行します。

ナビゲーションメニューから開始します。Credentials をクリックし、既存の認証情報オプションから選択します。ヒント: 便宜上およびセキュリティー上、認証情報のホスト専用の namespace を作成します。

Ansible 認証情報の作成時に指定する Ansible トークンとホストの URL は、認証情報の編集時にその認証情報を使用する自動化向けに、自動で更新されます。更新は、クラスターライフサイクル、ガバナンス、およびアプリケーション管理の自動化に関連するものなど、Ansible 認証情報を使用する自動化にコピーされます。これにより、認証情報の更新後も自動化が引き続き実行されます。

コンソールで認証情報を編集できます。Ansible 認証情報は、認証情報の更新時に、対象の認証情報を使用する自動化で、自動的に更新されあす。

認証情報を使用するクラスターの管理を終了する場合は、認証情報を削除して認証情報内にある情報を保護します。Actions を選択して、一括削除するか、削除する認証情報の横にあるオプションメニューを選択します。

1.3.9. オンプレミス環境の認証情報の作成

コンソールを使用してオンプレミス環境で Red Hat OpenShift Container Platform クラスターをデプロイおよび管理するには、認証情報が必要です。認証情報では、クラスターに使用される接続を指定します。

必要なアクセス権限: 編集

1.3.9.1. 前提条件

認証情報を作成する前に、以下の前提条件を満たす必要があります。

- デプロイされたハブクラスター。

- インフラストラクチャー環境に Kubernetes クラスターを作成できるようにするハブクラスターのインターネットアクセス。

- 切断された環境では、クラスター作成用のリリースイメージをコピーできるミラーレジストリーを設定している。詳細は、OpenShift Container Platform ドキュメントの 非接続インストールのイメージのミラーリング を参照してください。

- オンプレミス環境でのクラスターのインストールをサポートするアカウントの権限。

1.3.9.2. コンソールを使用した認証情報の管理

コンソールから認証情報を作成するには、コンソールで手順を完了します。

ナビゲーションメニューから開始します。Credentials をクリックし、既存の認証情報オプションから選択します。ヒント: 便宜上およびセキュリティー上、認証情報のホスト専用の namespace を作成します。

- 認証情報の種類に Host inventory を選択します。

- オプションで、認証情報の ベース DNS ドメイン を追加できます。ベース DNS ドメインを認証情報に追加した場合は、この認証情報でクラスターを作成すると、このベース DNS ドメインは自動的に正しいフィールドに設定されます。DNS ドメインを追加していない場合は、クラスターの作成時に追加できます。

- Red Hat OpenShift pull secret を入力します。Pull secret からプルシークレットをダウンロードします。プルシークレットの詳細は、イメージプルシークレットの使用 を参照してください。

- Add を選択して認証情報を作成します。

認証情報を使用するクラスターの管理を終了する場合は、認証情報を削除して認証情報内にある情報を保護します。Actions を選択して、一括削除するか、削除する認証情報の横にあるオプションメニューを選択します。

1.4. Kubernetes Operator クラスターのライフサイクルの概要のマルチクラスターエンジン

Kubernetes Operator のマルチクラスターエンジンは、クラスターフリート管理を強化するソフトウェア Operator です。Kubernetes Operator のマルチクラスターエンジンは、クラウドおよびデータセンター全体の Red Hat OpenShift Container Platform および Kubernetes クラスターライフサイクル管理をサポートします。

以下のドキュメントを参照してください。

1.4.1. クラスターライフサイクルのアーキテクチャー

Kubernetes のマルチクラスターエンジンは、ハブクラスター と マネージドクラスター の 2 つの主なタイプのクラスターを使用します。

ハブクラスターは、マルチクラスターエンジンがインストールされたメインクラスターです。ハブクラスターを使用して他の Kubernetes クラスターの作成、管理、および監視を行うことができます。マネージドクラスターは、ハブクラスターが管理する Kubernetes クラスターです。ハブクラスターを使用していくつかのクラスターを作成できますが、ハブクラスターによって管理される既存のクラスターをインポートすることもできます。

Kubernetes Operator を使用してマネージドクラスターを作成する場合は、Hive リソースを含む Red Hat OpenShift Container Platform クラスターインストーラーを使用してクラスターが作成されます。OpenShift Container Platform インストーラーでクラスターのインストールプロセスについての詳細は、OpenShift Container Platform ドキュメントの OpenShift Container Platform インストールの概要 を参照してください。

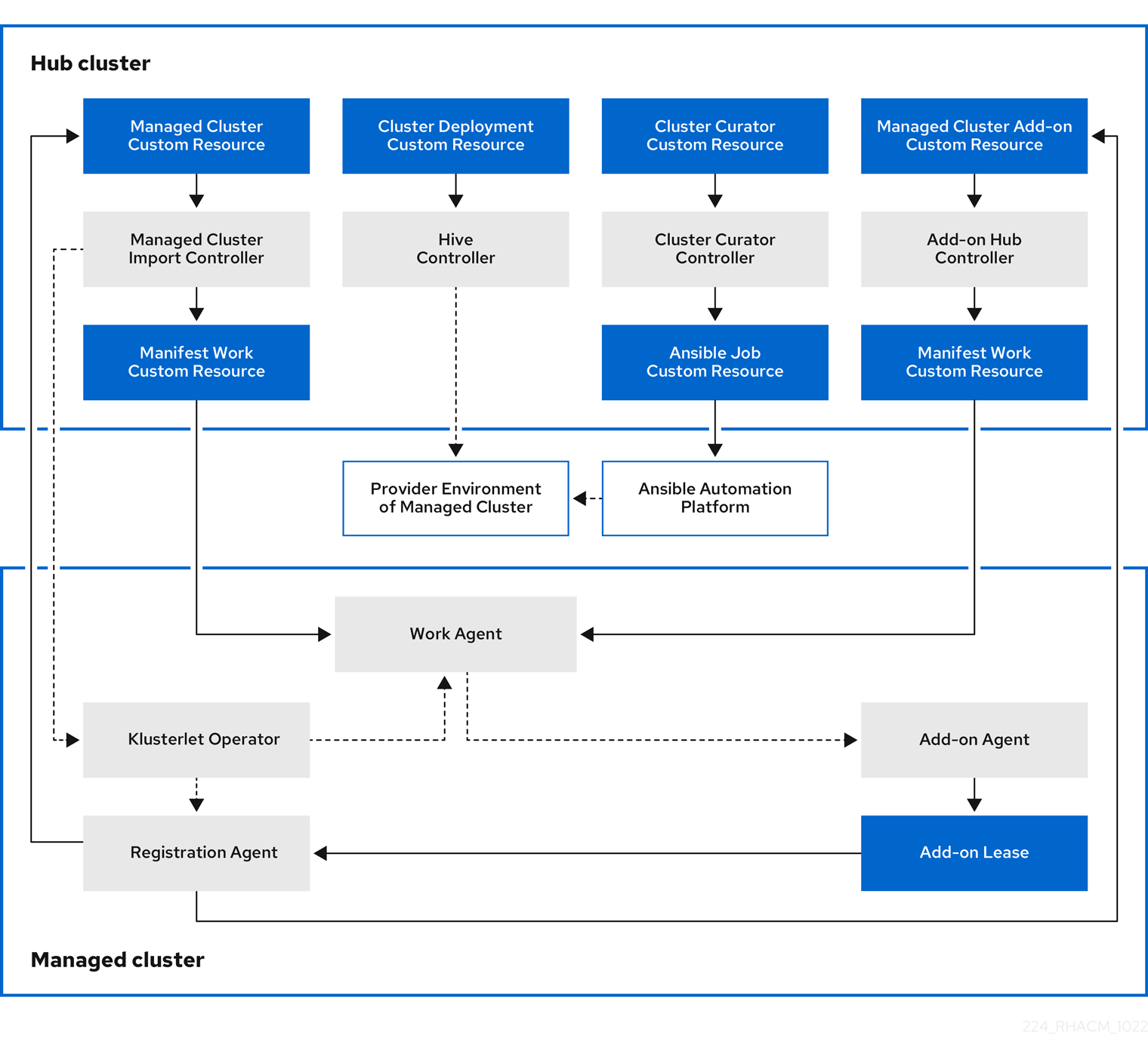

次の図は、クラスター管理に使用する Kubernetes Operator 用のマルチクラスターエンジンと共にインストールされるコンポーネントを示しています。

クラスターライフサイクル管理のアーキテクチャーのコンポーネントには、以下の項目が含まれます。

1.4.1.1. ハブクラスター

- マネージドクラスターのインポートコントローラー は、klusterlet Operator をマネージドクラスターにデプロイします。

- Hive コントローラー は、Kubernetes Operator 用のマルチクラスターエンジンを使用して作成したクラスターをプロビジョニングします。また、Hive コントローラーは、Kubernetes Operator 用のマルチクラスターエンジンによって作成されたマネージドクラスターを破棄します。

- クラスターキュレーターコントローラー は、マネージドクラスターの作成またはアップグレード時にクラスターインフラストラクチャー環境を設定するためのプレフックまたはポストフックとして Ansible ジョブを作成します。

- マネージドクラスターアドオンがハブクラスターで有効になると、その アドオンハブコントローラー がハブクラスターにデプロイされます。アドオンハブコントローラー は、アドオンエージェント をマネージドクラスターにデプロイします。

1.4.1.2. マネージドクラスター

- klusterlet Operator マネージドクラスターに登録およびワークコントローラーをデプロイします。

登録エージェント は、マネージドクラスターとマネージドクラスターアドオンをハブクラスターに登録します。登録エージェントは、管理対象クラスターと管理対象クラスターアドオンのステータスも維持します。次のアクセス許可が Clusterrole 内に自動的に作成され、マネージドクラスターがハブクラスターにアクセスできるようになります。

- エージェントは、ハブクラスターが管理する所有クラスターを取得または更新できます。

- エージェントが、ハブクラスターが管理する所有クラスターのステータスを更新できるようにします。

- エージェントが証明書をローテーションできるようにします。

-

エージェントが

coordination.k8s.ioリースをgetまたはupdateできるようにします。 -

エージェントがマネージドクラスターアドオンを

getできるようにします。 - エージェントがマネージドクラスターアドオンのステータスを更新できるようにします。

ワークエージェント マニフェストはマネージドクラスターで機能します。次のアクセス許可が Clusterrole 内に自動的に作成され、マネージドクラスターがハブクラスターにアクセスできるようになります。

- エージェントがハブクラスターにイベントを送信できるようにします。

-

エージェントが

manifestworksリソースをgetまたはupdateできるようにします。 -

エージェントが

manifestworksリソースのステータスを更新できるようにします。

- マネージドクラスターアドオンがハブクラスターのマネージドクラスター namespace に作成されると、そのハブコントローラーはマニフェスト作業を使用してそのエージェントデプロイリソースをマニフェストします。その後、作業エージェントはマニフェスト作業をマネージドクラスターに適用して、アドオンエージェントをデプロイします。

クラスターの追加と管理を続行するには、Kubernetes Operator クラスターライフサイクルのマルチクラスターエンジンの概要 を参照してください。

1.4.2. リリースイメージ

Kubernetes Operator 用のマルチクラスターエンジンを使用してプロバイダー上にクラスターを作成する場合は、新しいクラスターに使用するリリースイメージを指定する必要があります。リリースイメージでは、クラスターのビルドに使用する Red Hat OpenShift Container Platform のバージョンを指定します。

acm-hive-openshift-releases GitHub リポジトリーの YAML ファイルを使用して、リリースイメージを参照します。Red Hat Advanced Cluster Management はこれらのファイルを使用して、コンソールで利用可能なリリースイメージの一覧を作成します。これには、OpenShift Container Platform における最新の fast チャネルイメージが含まれます。コンソールには、OpenShift Container Platform の 3 つの最新バージョンの最新リリースイメージのみが表示されます。たとえば、コンソールオプションに以下のリリースイメージが表示される可能性があります。

- quay.io/openshift-release-dev/ocp-release:4.6.23-x86_64

- quay.io/openshift-release-dev/ocp-release:4.10.1-x86_64

注記: コンソールでクラスターの作成時に選択できるのは、visible: 'true' のラベルが付いたリリースイメージのみです。ClusterImageSet リソースのこのラベルの例は以下の内容で提供されます。

追加のリリースイメージは保管されますが、コンソールには表示されません。利用可能なすべてのリリースイメージを表示するには、CLI で kubectl get clusterimageset を実行します。最新のリリースイメージでクラスターを作成することが推奨されるため、コンソールには最新バージョンのみがあります。特定バージョンのクラスター作成が必要となる場合があります。そのため、古いバージョンが利用可能となっています。Red Hat Advanced Cluster Management はこれらのファイルを使用して、コンソールで利用可能なリリースイメージのリストを作成します。これには、OpenShift Container Platform における最新の fast チャネルイメージが含まれます。

リポジトリーには、clusterImageSets ディレクトリーと subscription ディレクトリーが含まれます。これらのディレクトリーは、リリースイメージの操作時に使用します。

clusterImageSets ディレクトリーには以下のディレクトリーが含まれます。

- Fast: サポート対象の各 OpenShift Container Platform バージョンのリリースイメージの内、最新バージョンを参照するファイルが含まれます。このフォルダー内のリリースイメージはテストされ、検証されており、サポートされます。

- Releases: 各 OpenShift Container Platform バージョン (stable、fast、および candidate チャネル) のリリースイメージをすべて参照するファイルが含まれます。注記: このリリースはすべてテストされ、安定していると判別されているわけではありません。

- Stable: サポート対象の各 OpenShift Container Platform バージョンのリリースイメージの内、最新の安定版 2 つを参照するファイルが含まれます。

注記: デフォルトでは、リリースイメージの現在のリストは 1 時間ごとに更新されます。製品をアップグレードした後、リストに製品の新しいバージョンの推奨リリースイメージバージョンが反映されるまでに最大 1 時間かかる場合があります。

独自の ClusterImageSets は以下の 3 つの方法でキュレートできます。

3 つの方法のいずれかの最初のステップは、最新の fast チャンネルイメージを自動的に更新する付属のサブスクリプションを無効にすることです。最新の fast の ClusterImageSets の自動キュレーションを無効にするには、multiclusterhub リソースでインストーラーパラメーターを使用します。spec.disableUpdateClusterImageSets パラメーターを true と false の間で切り替えることにより、Red Hat Advanced Cluster Management でインストールしたサブスクリプションが、それぞれ無効または有効になります。独自のイメージをキューレートする場合は、spec.disableUpdateClusterImageSets を true に設定してサブスクリプションを無効にします。

オプション 1: クラスターの作成時にコンソールで使用する特定の ClusterImageSet のイメージ参照を指定します。指定する新規エントリーはそれぞれ保持され、将来のすべてのクラスタープロビジョニングで利用できます。たとえば、エントリーは quay.io/openshift-release-dev/ocp-release:4.6.8-x86_64 のようになります。

オプション 2: GitHub リポジトリー acm-hive-openshift-releases から YAML ファイル ClusterImageSets を手動で作成し、適用します。

オプション 3: GitHub リポジトリー acm-hive-openshift-releases の README.md に従って、フォークした GitHub リポジトリーから ClusterImageSets の自動更新を有効にします。

subscription ディレクトリーには、リリースイメージの一覧がプルされる場所を指定するファイルが含まれます。

Red Hat Advanced Cluster Management のデフォルトのリリースイメージは、Quay.io デフォルトで提供されます。

イメージは、acm-hive-openshift-releases GitHub repository for release 2.5 のファイルで参照されます。

1.4.2.1. 別のアーキテクチャーにクラスターをデプロイするためのリリースイメージの作成

両方のアーキテクチャーのファイルを含むリリースイメージを手動で作成することで、ハブクラスターのアーキテクチャーとは異なるアーキテクチャーでクラスターを作成できます。

たとえば、ppc64le、aarch64、または s390x アーキテクチャーで実行されているハブクラスターから x86_64 クラスターを作成する必要があるとします。両方のファイルセットでリリースイメージを作成する場合に、新規のリリースイメージにより OpenShift Container Platform リリースレジストリーがマルチアーキテクチャーイメージマニフェストを提供できるので、クラスターの作成は成功します。

OpenShift Container Platform 4.11 以降は、デフォルトで複数のアーキテクチャーをサポートします。以下の clusterImageSet を使用してクラスターをプロビジョニングできます。

複数のアーキテクチャーをサポートしない OpenShift Container Platform イメージのリリースイメージを作成するには、アーキテクチャータイプについて以下のような手順を実行します。

OpenShift Container Platform リリースレジストリー から、

x86_64、s390x、aarch64、およびppc64leリリースイメージを含む マニフェスト一覧 を作成します。以下のコマンド例を使用して、Quay リポジトリー から環境内の両方のアーキテクチャーのマニフェストリストをプルします。

podman pull quay.io/openshift-release-dev/ocp-release:4.10.1-x86_64 podman pull quay.io/openshift-release-dev/ocp-release:4.10.1-ppc64le podman pull quay.io/openshift-release-dev/ocp-release:4.10.1-s390x podman pull quay.io/openshift-release-dev/ocp-release:4.10.1-aarch64

podman pull quay.io/openshift-release-dev/ocp-release:4.10.1-x86_64 podman pull quay.io/openshift-release-dev/ocp-release:4.10.1-ppc64le podman pull quay.io/openshift-release-dev/ocp-release:4.10.1-s390x podman pull quay.io/openshift-release-dev/ocp-release:4.10.1-aarch64Copy to Clipboard Copied! Toggle word wrap Toggle overflow イメージを管理するプライベートリポジトリーにログインします。

podman login <private-repo>

podman login <private-repo>Copy to Clipboard Copied! Toggle word wrap Toggle overflow private-repoは、リポジトリーへのパスに置き換えます。環境に適用される以下のコマンドを実行して、リリースイメージマニフェストをプライベートリポジトリーに追加します。

podman push quay.io/openshift-release-dev/ocp-release:4.10.1-x86_64 <private-repo>/ocp-release:4.10.1-x86_64 podman push quay.io/openshift-release-dev/ocp-release:4.10.1-ppc64le <private-repo>/ocp-release:4.10.1-ppc64le podman push quay.io/openshift-release-dev/ocp-release:4.10.1-s390x <private-repo>/ocp-release:4.10.1-s390x podman push quay.io/openshift-release-dev/ocp-release:4.10.1-aarch64 <private-repo>/ocp-release:4.10.1-aarch64

podman push quay.io/openshift-release-dev/ocp-release:4.10.1-x86_64 <private-repo>/ocp-release:4.10.1-x86_64 podman push quay.io/openshift-release-dev/ocp-release:4.10.1-ppc64le <private-repo>/ocp-release:4.10.1-ppc64le podman push quay.io/openshift-release-dev/ocp-release:4.10.1-s390x <private-repo>/ocp-release:4.10.1-s390x podman push quay.io/openshift-release-dev/ocp-release:4.10.1-aarch64 <private-repo>/ocp-release:4.10.1-aarch64Copy to Clipboard Copied! Toggle word wrap Toggle overflow private-repoは、リポジトリーへのパスに置き換えます。新規情報のマニフェストを作成します。

podman manifest create mymanifest

podman manifest create mymanifestCopy to Clipboard Copied! Toggle word wrap Toggle overflow 両方のリリースイメージへの参照をマニフェスト一覧に追加します。

podman manifest add mymanifest <private-repo>/ocp-release:4.10.1-x86_64 podman manifest add mymanifest <private-repo>/ocp-release:4.10.1-ppc64le podman manifest add mymanifest <private-repo>/ocp-release:4.10.1-s390x podman manifest add mymanifest <private-repo>/ocp-release:4.10.1-aarch64

podman manifest add mymanifest <private-repo>/ocp-release:4.10.1-x86_64 podman manifest add mymanifest <private-repo>/ocp-release:4.10.1-ppc64le podman manifest add mymanifest <private-repo>/ocp-release:4.10.1-s390x podman manifest add mymanifest <private-repo>/ocp-release:4.10.1-aarch64Copy to Clipboard Copied! Toggle word wrap Toggle overflow private-repoは、リポジトリーへのパスに置き換えます。マニフェストリストの一覧を既存のマニフェストにマージします。

podman manifest push mymanifest docker://<private-repo>/ocp-release:4.10.1

podman manifest push mymanifest docker://<private-repo>/ocp-release:4.10.1Copy to Clipboard Copied! Toggle word wrap Toggle overflow private-repoは、リポジトリーへのパスに置き換えます。

ハブクラスターで、リポジトリーのマニフェストを参照するリリースイメージを作成します。

以下の例のような情報を含む YAML ファイルを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow private-repoは、リポジトリーへのパスに置き換えます。ハブクラスターで以下のコマンドを実行し、変更を適用します。

oc apply -f <file-name>.yaml

oc apply -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow file-nameを、先の手順で作成した YAML ファイルの名前に置き換えます。

- OpenShift Container Platform クラスターの作成時に新規リリースイメージを選択します。

- Red Hat Advanced Cluster Management コンソールを使用してマネージドクラスターをデプロイする場合は、クラスター作成のプロセス時に Architecture フィールドにマネージドクラスターのアーキテクチャーを指定します。

作成プロセスでは、マージされたリリースイメージを使用してクラスターを作成します。

1.4.2.2. 非接続時におけるリリースイメージのカスタム一覧の管理

ハブクラスターにインターネット接続がない場合は、リリースイメージのカスタムリストを管理しないといけない場合があります。クラスターの作成時に利用可能なリリースイメージのカスタムリストを作成します。非接続時に、利用可能なリリースイメージを管理するには、以下の手順を実行します。

- オンラインシステムを使用している場合は、GitHub リポジトリー acm-hive-openshift-releases に移動し、バージョン 2.5 で利用可能なクラスターイメージセットにアクセスします。

-

clusterImageSetsディレクトリーを、切断された Kubernetes Operator ハブクラスター用のマルチクラスターエンジンにアクセスできるシステムにコピーします。 管理対象クラスターに適合する次の手順を実行して、管理対象クラスターと切断されたリポジトリーの間にクラスターイメージセットを含むマッピングを追加します。

-

OpenShift Container Platform マネージドクラスターの場合は、

ImageContentSourcePolicyオブジェクトを使用してマッピングを完了する方法についての詳細は、イメージレジストリーリポジトリーのミラーリングの設定 を参照してください。 -

OpenShift Container Platform クラスターではないマネージドクラスターの場合は、

ManageClusterImageRegistryCRD を使用してイメージセットの場所を上書きします。マッピング用にクラスターを上書きする方法については、カスタム ManagedClusterImageRegistry CRD を使用したクラスターのインポート を参照してください。

-

OpenShift Container Platform マネージドクラスターの場合は、

-

clusterImageSetYAML を手作業で追加し、Red Hat Advanced Cluster Management for Kubernetes コンソールを使用してクラスターを作成する時に利用できるようにイメージの YAML ファイルを追加します。 残りの OpenShift Container Platform リリースイメージの

clusterImageSetYAML ファイルを、イメージの保存先の正しいオフラインリポジトリーを参照するように変更します。更新は次の例のようになります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow YAML ファイルで参照されているオフラインイメージレジストリーにイメージがロードされていることを確認します。

各 YAML ファイルに以下のコマンドを入力して、各

clusterImageSetsを作成します。oc create -f <clusterImageSet_FILE>

oc create -f <clusterImageSet_FILE>Copy to Clipboard Copied! Toggle word wrap Toggle overflow clusterImageSet_FILEを、クラスターイメージセットファイルの名前に置き換えます。以下は例になります。oc create -f img4.11.9-x86_64.yaml

oc create -f img4.11.9-x86_64.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 追加するリソースごとにこのコマンドを実行すると、利用可能なリリースイメージの一覧が使用できるようになります。

- または Red Hat Advanced Cluster Management のクラスター作成のコンソールに直接イメージの URL を貼り付けることもできます。イメージ URL が存在しない場合は、イメージ URL を追加すると新しい clusterImageSets が作成されます。

- クラスターの作成時に、Red Hat Advanced Cluster Management コンソールで現在利用可能なリリースイメージの一覧を表示します。

1.4.3. インフラストラクチャー環境の作成

コンソールを使用してインフラストラクチャー環境を作成し、ホストを管理してそのホスト上にクラスターを作成できます。

インフラストラクチャー環境は、次の機能をサポートしています。

- クラスターのゼロタッチプロビジョニング: スクリプトを使用してクラスターをデプロイメントします。詳細は、Red Hat OpenShift Container Platform ドキュメントの 切断された環境での GitOps ZTP のインストール を参照してください。

- 遅延バインディング: 既存のクラスターにノードを追加します。インフラストラクチャー管理者はホストを起動でき、クラスター作成者は後でホストを既存のクラスターにバインドできます。遅延バインディングを使用する場合は、クラスター作成者がインフラストラクチャーにアクセスするのに管理者権限は必要ありません。

-

デュアルスタック: IPv4 と IPv6 の両方のアドレスを持つクラスターをデプロイします。デュアルスタックは、

OVN-Kubernetesネットワーク実装を使用して、複数のサブネットをサポートします。 - リモートワーカーノードの追加: リモートワーカーノードを作成して実行した後、クラスターに追加します。これにより、バックアップ目的で他の場所にノードを追加する柔軟性が提供されます。

- NMState を使用した静的 IP: NMState API を使用して、環境の静的 IP アドレスを定義します。

1.4.3.1. 前提条件

インフラストラクチャー環境を作成する前に、以下の前提条件を確認してください。

- OpenShift Container Platform をハブクラスターにデプロイする必要があります。

- クラスターを作成するために必要なイメージを取得するためのハブクラスターへのインターネットアクセス (接続済み)、あるいはインターネットへの接続がある内部またはミラーレジストリーへの接続 (非接続) がある。

- ハブクラスター上にある設定済みの Central Infrastructure Management (CIM) 機能のインスタンスがある。

- Bare Metal Operator をハブクラスターにインストールする必要がある。

- OpenShift Container Platform プルシークレット がある。詳細は、イメージプルシークレットの使用 を参照してください。

-

デフォルトで

~/.ssh/id_rsa.pubファイルに SSH キーがある。 - 設定済みのストレージクラスがある。

- 切断された環境のみ: OpenShift Container Platform のドキュメントで、ネットワーク遠端のクラスター の手順を完了します。

1.4.3.2. Central Infrastructure Management サービスの有効化

Central Infrastructure Management サービスは、Kubernetes 用のマルチクラスターエンジンで提供され、OpenShift Container Platform クラスターをデプロイします。CIM は、ハブクラスターで MultiClusterHub Operator を有効にするとデプロイされますが、有効にする必要があります。

CIM サービスを有効にするには、以下の手順を実行します。

重要: ハブクラスターが次のプラットフォームのいずれかにインストールされている場合のみ: ベアメタル、Red Hat OpenStack Platform、VMware vSphere、またはユーザープロビジョニングインフラストラクチャー (UPI) 方式を使用してインストールされ、プラットフォームが None の場合のみ、次の手順を実行します。ハブクラスターが他のプラットフォームにある場合は、この手順を省略します。

provisioningリソースを変更し、以下のコマンドを実行してベアメタル Operator がすべての namespace を監視できるようにします。oc patch provisioning provisioning-configuration --type merge -p '{"spec":{"watchAllNamespaces": true }}'oc patch provisioning provisioning-configuration --type merge -p '{"spec":{"watchAllNamespaces": true }}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 非接続環境: では、インフラストラクチャー Operator と 同じ namespace に

ConfigMapを作成し、ミラーレジストリーのca-bundle.crtおよびregistries.confの値を指定します。ファイルのConfigMapは以下の例のようになります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.4.3.2.1. AgentServiceConfig カスタムリソースの作成

以下の手順を実行して AgentServiceConfig カスタムリソースを作成します。

切断された環境のみ: 次の

YAMLコンテンツをagent_service_config.yamlファイルに保存し、必要に応じて値を置き換えます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow mirror_configは、ミラーレジストリー設定の詳細が含まれるConfigMapの名前に置き換えます。認証を必要としないミラーレジストリーを使用している場合は、オプションの

unauthenticated_registryパラメーターを含めます。このリストのエントリーは検証されず、プルシークレットにエントリーを含める必要はありません。-

接続環境の場合のみ: 次の

YAMLコンテンツをagent_service_config.yamlファイルに保存します。

+ db_volume_size は databaseStorage フィールドのボリュームサイズに置き換えます (例: 10Gi )。この値は、クラスターのデータベーステーブルやデータベースビューなどのファイルを格納するために割り当てられるストレージの量を指定します。クラスターが多い場合は、より高い値を使用する必要がある場合があります。

+ fs_volume_size は filesystemStorage フィールドのボリュームのサイズに置き換えます (例: クラスターごとに 200M、サポートされる OpenShift Container Platform バージョンごとに 2-3Gi)。必要な最小値は 100Gi です。この値は、クラスターのログ、マニフェスト、および kubeconfig ファイルを保存するために割り当てられるストレージのサイズを指定します。クラスターが多い場合は、より高い値を使用する必要がある場合があります。

+ img_volume_size を imageStorage フィールドのボリュームのサイズに置き換えます (例: オペレーティングシステムイメージごとに 2Gi)。最小サイズは 50Gi です。この値は、クラスターのイメージに割り当てられるストレージの量を指定します。実行中の Red Hat Enterprise Linux CoreOS の各インスタンスに 1 GB のイメージストレージを許可する必要があります。Red Hat Enterprise Linux CoreOS のクラスターおよびインスタンスが多数ある場合は、より高い値を使用する必要がある場合があります。

+ ocp_version は、インストールする OpenShift Container Platform バージョンに置き換えます。

+ ocp_release_version は、特定のインストールバージョン (例: 49.83.2021032516400) に置き換えます。

+ iso_url は、ISO URL に置き換えます (例:https://mirror.openshift.com/pub/openshift-v4/x86_64/dependencies/rhcos/4.10/4.10.3/rhcos-4.10.3-x86_64-live.x86_64.iso)。他の値は https://mirror.openshift.com/pub/openshift-v4/x86_64/dependencies/rhcos/4.10/4.10.3/ にあります。

次のコマンドを実行して、

AgentServiceConfigカスタムリソースを作成します。oc create -f agent_service_config.yaml

oc create -f agent_service_config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力は次の例のような内容になります。

agentserviceconfig.agent-install.openshift.io/agent created

agentserviceconfig.agent-install.openshift.io/agent createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow