アプリケーション

アプリケーション管理

概要

第1章 アプリケーションの管理

アプリケーションの作成、デプロイ、および管理に関する詳細は、以下のトピックを参照してください。このガイドでは、Kubernetes の概念および用語に精通していることを前提としています。主要な Kubernetes の用語はコンポーネントは、定義しません。Kubernetes の概念に関する情報は、Kubernetes ドキュメント を参照してください。

アプリケーション管理機能では、アプリケーションや、アプリケーションの更新を構築してデプロイするオプションが統一、簡素化されています。開発者および DevOps 担当者は、このアプリケーション管理機能を使用することで、チャネルおよびサブスクリプションベースの自動化を使用し、環境全体でアプリケーションを作成して管理できます。

重要: アプリケーション名は 37 文字を超えることができません。

以下のトピックを参照してください。

1.1. アプリケーションモデルおよび定義

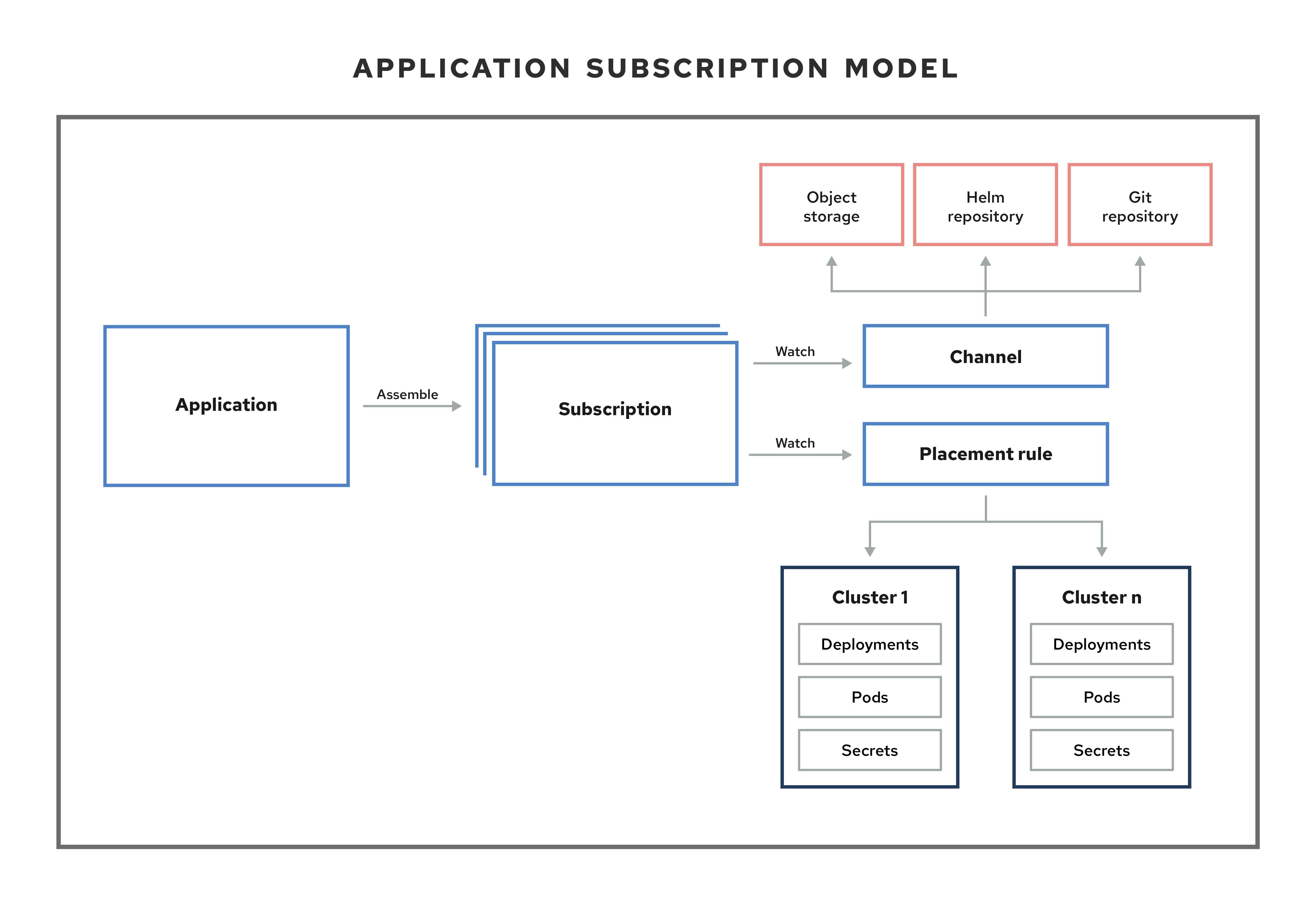

アプリケーションモデルは、マネージドクラスターにデプロイされるリソースが含まれる 1 つまたは複数の Kubernetes リソースリポジトリー (チャネル リソース) にサブスクライブすることをベースとしています。単一クラスターアプリケーションもマルチクラスターアプリケーションも同じ Kubernetes 仕様を使用しますが、マルチクラスターアプリケーションでは、デプロイメントおよびアプリケーション管理ライフサイクルがさらに自動化されます。

アプリケーションモデルの詳細を理解するには、以下のイメージを参照してください。

以下のアプリケーションリソースセクションを確認します。

1.1.1. アプリケーション

Red Hat Advanced Cluster Management for Kubernetes のアプリケーション (application.app.k8s.io) は、アプリケーションを設定する Kubernetes リソースのグループ化に使用します。

Red Hat Advanced Cluster Management for Kubernetes アプリケーションのアプリケーションコンポーネントリソースはすべて、YAML ファイルの仕様セクションで定義します。アプリケーションコンポーネントリソースを作成または更新する必要がある場合は、適切な仕様セクションを作成してリソースを定義するラベルを追加する必要があります。

OpenShift Container Platform GitOps またはクラスターにインストールされている Argo CD Operator によって検出されるアプリケーションである Discovered アプリケーションと連携することもできます。同じリポジトリーを共有するアプリケーションは、このビューでグループ化されます。

1.1.2. サブスクリプション

サブスクリプション (subscription.apps.open-cluster-management.io) により、クラスターは Git リポジトリー、Helm リリースリポジトリー、またはオブジェクトストレージリポジトリーなどのソースリポジトリー (チャネル) にサブスクライブできます。

ハブクラスターが自己管理の場合には、サブスクリプションはハブクラスターにローカルでアプリケーションリソースをデプロイできます。トポロジーで local-cluster (自己管理のハブクラスター) サブスクリプションを表示できます。リソース要件は、ハブクラスターのパフォーマンスに悪影響を与える可能性があります。

サブスクリプションは、チャネルまたはストレージの場所を参照して、新規または更新したリソーステンプレートを特定できます。次に、サブスクリプション operator は、先にハブクラスターを確認しなくても、直接ストレージの場所からターゲットのマネージドクラスターにダウンロードしてデプロイできます。サブスクリプションを使用すると、サブスクリプション operator は、ハブクラスターの代わりに、新規または更新されたリソースがないか、チャネルを監視できます。

以下のサブスクリプションアーキテクチャーイメージを参照してください。

1.1.2.1. チャネル

チャネル (channel.apps.open-cluster-management.io) は、クラスターがサブスクリプションを使用してサブスクライブ可能なソースリポジトリーを定義します。許容タイプは、Git、Helm リリース、オブジェクトストレージリポジトリー、ハブクラスター上にあるリソーステンプレートです。

認可が必要なチャネルから Kubernetes リソースまたは Helm チャートを必要とするアプリケーション (例: エンタイトルメントのある Git リポジトリー) がある場合は、これらのチャネルにアクセスできるようにするシークレットを使用できます。お使いのサブスクリプションで、データセキュリティーを確保しつつも、これらのチャネルからデプロイメント用の Kubernetes リソースおよび Helm チャートにアクセスできます。

チャネルは、ハブクラスター内の namespace を使用して、リソースをデプロイメント用に保存する、物理的な場所を参照します。クラスターは、チャネルにサブスクライブすることで、クラスターごとにデプロイするリソースを特定できます。

注記: 一意の namespace に各チャネルを作成することを推奨します。ただし、Git チャネルは、Git、Helm、オブジェクトストレージなどの別のチャネルタイプで namespace を共有できます。

チャネル内のリソースには、そのチャネルにサブスクライブするクラスターのみがアクセスできます。

1.1.2.1.1. サポート対象の Git リポジトリーサーバー

- GitHub

- GitLab

- Bitbucket

- Gogs

1.1.2.2. 配置ルール

配置ルール (placementrule.apps.open-cluster-management.io) は、リソーステンプレートをデプロイ可能なターゲットクラスターを定義します。配置ルールを使用すると、deployable のマルチクラスターでのデプロイメントが容易になります。配置ルールは、ガバナンスポリシーおよびリスクポリシーにも使用されます。使用方法の詳細は、ガバナンス を参照してください。

1.1.3. ApplicationSet

ApplicationSet は Argo CD のサブプロジェクトで、GitOps Operator によりサポートされています。ApplicationSet は Argo CD アプリケーションのマルチクラスターサポートを追加します。Red Hat Advanced Cluster Management コンソールからアプリケーションを作成できます。

注記: ApplicationSet をデプロイするための前提条件の詳細については、マネージドクラスターの GitOps への登録 を参照してください。

OpenShift Container Platform GitOps は Argo CD を使用してクラスターリソースを維持します。Argo CD は、アプリケーションの継続的インテグレーションおよび継続的デプロイメント (CI/CD) のオープンソースの宣言型ツールです。OpenShift Container Platform GitOps は Argo CD をコントローラー (OpenShift Container Platform GitOps Operator) として実装し、Git リポジトリーで定義されるアプリケーション定義および設定を継続的に監視できるようにします。次に、Argo CD は、これらの設定の指定された状態をクラスターのライブ状態と比較します。

ApplicationSet コントローラーは、GitOps Operator インスタンスを使用してクラスターにインストールされ、cluster-administrator に焦点を当てたシナリオをサポートする機能を追加することでクラスターを補完します。ApplicationSet コントローラーは以下の機能を提供します。

- 単一の Kubernetes マニフェストを使用して、GitOps Operator で複数の Kubernetes クラスターをターゲットにする機能。

- 単一の Kubernetes マニフェストを使用して、GitOps Operator を含む 1 つまたは複数の Git リポジトリーから複数のアプリケーションをデプロイする機能。

- monorepo のサポートの改善。これは単一の Git リポジトリー内で定義されている複数の Argo CD アプリケーションリソースである Argo CD のコンテキストに含まれます。

- マルチクラスター内での個別クラスターテナントの機能の向上。特権のあるクラスター管理者を使用して宛先のクラスター/namespace を有効にする必要なく、Argo CD でアプリケーションをデプロイできます。

ApplicationSet Operator はクラスターデシジョンジェネレーターを使用して、カスタムリソース固有のロジックでデプロイするマネージドクラスターを決定する Kubernetes カスタムリソースをインターフェイスします。クラスターデシジョンリソースは、マネージドクラスターのリストを生成し、これを ApplicationSet リソースの template フィールドにレンダリングします。これは、参照される Kubernetes リソースの完全な形状に関する知識を必要としないダックタイピングを使用して行われます。

ApplicationSet 内の generators.clusterDecisionResource 値の例を参照してください。

以下の Placement を参照してください。

ApplicationSets の詳細は、Cluster Decision Resource Generator を参照してください。

1.1.4. アプリケーションドキュメント

詳細情報は、以下のドキュメントを参照してください。

1.2. アプリケーションコンソール

コンソールには、アプリケーションライフサイクル管理用のダッシュボードが含まれます。コンソールダッシュボードを使用し、アプリケーションの作成および管理、アプリケーションステータスの表示が可能です。機能が強化され、開発者およびオペレーションスタッフは全クラスターのアプリケーションの作成、デプロイ、更新、管理、可視化がしやすくなります。

以下のリストのコンソール機能の一部を参照し、制約、アクション、トポロジーの読み取り方法に関するガイド付きの情報は、コンソールを参照してください。

重要: 利用可能なアクションは割り当てられたロールに基づきます。ロールベースのアクセス制御 のドキュメントで、アクセス要件を確認してください。

- 関連するリソースリポジトリーやサブスクリプションおよび配置設定など、クラスター全体にデプロイされたアプリケーションを可視化する。

-

アプリケーションの作成および編集とリソースのサブスクライブを行います。Actions メニューから、検索、編集、または削除が可能です。

YAML:Onを選択し、フィールドの更新時に YAML を表示して編集します。 - メインの Overview タブから、アプリケーション名をクリックして、リソースリポジトリー、サブスクリプション、配置ルール、Ansible Automation Platform タスクを使用する (git リポジトリー用の) デプロイメント前後のフックなどのデプロイされたリソースなど、詳細やアプリケーションリソースを表示できます。概要からアプリケーションを作成することもできます。

ApplicationSet、Subscription、OpenShift、Flux、および Argo CD タイプなどのアプリケーションを作成および表示します。

ApplicationSetは、このコントローラーから生成される Argo アプリケーションを表します。-

Argo CD

ApplicationSetを作成するには、Sync policyからAutomatically sync when cluster state changesを有効にする必要があります。 -

kustomizationコントローラーを使用する Flux の場合は、kustomize.toolkit.fluxcd.io/name=<app_name>ラベルが付いた Kubernetes リソースを見つけます。 -

helmコントローラーを使用する Flux の場合は、helm.toolkit.fluxcd.io/name=<app_name>ラベルが付いた Kubernetes リソースを見つけます。

-

Argo CD

-

注記:

ApplicationSetを作成するには、GitOps クラスターリソースと GitOps Operator がインストールされている必要があります。これらの前提条件がないと、コンソールに Argo サーバー オプションが表示されず、ApplicationSetは作成されません。 - メインの Overview から、表のアプリケーション名をクリックして単一のアプリケーションの概要を表示すると、以下の情報を確認できます。

- リソースのステータスなどのクラスターの詳細

- リソーストポロジー

- サブスクリプションの情報

- Editor タブにアクセスして編集します。

-

Topology タブをクリックして、プロジェクトのすべてのアプリケーションおよびリソースを視覚的に表示します。Helm サブスクリプションの場合は、パッケージの上書きの設定 を参照し、適切な

packageNameおよびpackageAliasを定義して、正確なトポロジー表示を取得します。 - Advanced configuration タブをクリックして、全アプリケーションのリソースの用語および表を表示します。リソースを特定し、サブスクリプション、配置、配置ルール、チャネルをフィルタリングできます。アクセス権がある場合は、編集、検索、削除などの Actions も複数、クリックできます。

- Ansible タスクをデプロイしたアプリケーションの prehook または posthook として使用している場合に、成功した Ansible Automation Platform デプロイメントを表示します。

- Launch resource in Search をクリックし、関連リソースを検索します。

Search を使用して、各リソースのコンポーネント

kind別にアプリケーションリソースを検索します。リソースの検索には、以下の値を使用します。Expand アプリケーションリソース Kind (検索パラメーター) サブスクリプション

Subscriptionチャネル

Channelシークレット

SecretPlacement

Placement配置ルール

PlacementRuleアプリケーション

アプリケーション

また、名前、namespace、クラスター、ラベルなどの他のフィールドで検索することもできます。検索の使用方法は、コンソールでの検索の概要 を参照してください。

1.3. サブスクリプションレポート

サブスクリプションレポートは、フリート内のすべてのマネージドクラスターからのアプリケーションステータスのコレクションです。具体的には、親アプリケーションリソースは、スケーラブルなマネージドクラスターからのレポートを保持できます。

詳細なアプリケーションステータスはマネージドクラスターで利用できますが、ハブクラスターの subscriptionReports は軽量でスケーラブルです。以下の 3 種類のサブ状態レポートを参照してください。

-

パッケージレベルの

SubscriptionStatus: これは、マネージドクラスター上のアプリケーションパッケージのステータスであり、アプリケーションによってappsubnamespace にデプロイされるすべてのリソースの詳細なステータスが含まれます。 -

クラスターレベルの

SubscriptionReport: 特定のクラスターにデプロイされているすべてのアプリケーションに関する全体的なステータスレポートです。 アプリケーションレベルの

SubscriptionReport: これは、特定のアプリケーションがデプロイされたすべてのマネージドクラスターの全体的なステータスレポートです。

1.3.1. SubscriptionStatus パッケージレベル

パッケージレベルのマネージドクラスターのステータスは、マネージドクラスターの <namespace:<your-appsub-namespace> にあり、アプリケーションでデプロイされたすべてのリソースの詳細ステータスが含まれます。マネージドクラスターにデプロイされるすべての appsub に対して、マネージドクラスターの appsub namespace に SubscriptionStatus CR が作成されます。エラーが存在する場合は、すべてのリソースが詳細エラーと共に報告されます。

以下の SubscriptionStatus サンプル YAML ファイルを参照してください。

1.3.2. SubscriptionReport クラスターレベル

クラスターレベルのステータスはハブクラスターの <namespace:<your-managed-cluster-1> にあり、そのマネージドクラスターの各アプリケーションの全体的なステータスのみが含まれます。ハブクラスターの各クラスター namespace の subscriptionReport は、以下のステータスのいずれかを報告します。

-

Deployed -

Failed -

propagationFailed

以下の SubscriptionStatus サンプル YAML ファイルを参照してください。

1.3.3. SubscriptionReport アプリケーションレベル

各アプリケーションのアプリケーションレベルの 1 つである subscriptionReport が、ハブクラスターの appsub namespace の <namespace:<your-appsub-namespace> にあり、以下の情報が含まれています。

- 各マネージドクラスターのアプリケーション全体のステータス

- アプリケーションのすべてのリソースのリスト

- クラスターの合計数を含むレポートサマリー

-

アプリケーションがステータスにあるクラスターの合計数 (

deployed、failed、propagationFailed、およびinProgress) のレポートサマリー。

注記: inProcess ステータスは、合計マイナス deployed、さらに failed `, と `propagationFailed をマイナスします。

以下の SubscriptionStatus サンプル YAML ファイルを参照してください。

1.3.4. ManagedClusterView

ManagedClusterView CR は、最初の failed クラスターについて報告されます。リソースのデプロイに失敗した複数のクラスターにアプリケーションがデプロイされた場合、ハブクラスターで最初に失敗したクラスター namespace に対して managedClusterView CR が 1 つだけが作成されます。managedClusterView CR は、障害が発生したクラスターから詳細なサブスクリプションステータスを取得するため、アプリケーションの所有者は障害が発生したリモートクラスターにアクセスする必要がありません。

以下のコマンドを実行してステータスを取得できます。

% oc get managedclusterview -n <failing-clusternamespace> "<app-name>-<app name>"

% oc get managedclusterview -n <failing-clusternamespace> "<app-name>-<app name>"1.3.5. CLI アプリケーションレベルのステータス

マネージドクラスターにアクセスしてサブスクリプションステータスを取得できない場合は、CLI を使用できます。クラスターレベルまたはアプリケーションレベルのサブスクリプションレポートは、全体のステータスは含まれますが、アプリケーションの詳細なエラーメッセージは含まれません。

- multicloud-operators-subscription から CLI をダウンロードします。

-

以下のコマンドを実行して

managedClusterViewリソースを作成し、エラーを特定できるようにマネージドクラスターアプリケーションのSubscriptionStatusを表示します。

% getAppSubStatus.sh -c <your-managed-cluster> -s <your-appsub-namespace> -n <your-appsub-name>

% getAppSubStatus.sh -c <your-managed-cluster> -s <your-appsub-namespace> -n <your-appsub-name>1.3.6. CLI 最終更新時間

また、各マネージドクラスターにログインしてこの情報を取得する場合は、指定のマネージドクラスターでの AppSub の最終更新時間を取得することもできます。そのため、マネージドクラスターの AppSub の最終更新時間の取得を簡素化するために、ユーティリティースクリプトが作成されました。このスクリプトは、ハブクラスターで実行するように設計されています。これは、マネージドクラスターから AppSub を取得するための managedClusterView リソースを作成し、データを解析して最終更新時刻を取得します。

- multicloud-operators-subscription から CLI をダウンロードします。

-

以下のコマンドを実行して、マネージドクラスターの

AppSubの最終更新時間を取得します。このスクリプトは、ハブクラスターで実行するように設計されています。managedClusterViewリソースを作成してマネージドクラスターから AppSub を取得し、データを解析して最終更新時間を取得します。

% getLastUpdateTime.sh -c <your-managed-cluster> -s <your-appsub-namespace> -n <your-appsub-name>

% getLastUpdateTime.sh -c <your-managed-cluster> -s <your-appsub-namespace> -n <your-appsub-name>1.4. アプリケーションリソースの管理

コンソールから、Git リポジトリー、Helm リポジトリー、およびオブジェクトストレージリポジトリーを使用してアプリケーションを作成できます。

重要: Git チャネルは、他のすべてのチャネルタイプ (Helm、オブジェクトストレージ、およびその他の Git namespace) と namespace を共有できます。

アプリケーションの管理を開始する場合は、以下のトピックを参照してください。

1.4.1. Git リポジトリーを使用したアプリケーションの管理

アプリケーションを使用して Kubernetes リソースをデプロイする場合に、リソースは特定のリポジトリーに配置されます。以下の手順で、Git リポジトリーからリソースをデプロイする方法を説明します。アプリケーションモデルおよび定義 でアプリケーションモデルを確認してください。

ユーザーに必要なアクセス権: アプリケーションを作成できるユーザーロールロールが割り当てられているアクションのみを実行できます。ロールベースのアクセス制御 のドキュメントで、アクセス要件を確認してください。

- コンソールのナビゲーションメニューから Applications をクリックし、リスト表示されているアプリケーションを表示して新規アプリケーションを作成します。

- オプション: 作成するアプリケーションの種類を選択した後に、YAML: On を選んで YAML: アプリケーションの作成および編集時に YAML をコンソールで表示できます。このトピックの後半にある YAML サンプルを参照してください。

使用可能なリポジトリーのリストから Git を選択し、正しいフィールドに値を入力します。コンソールのガイダンスに従い、入力に基づいて YAML エディターの変更値を確認します。

注記:

- 既存の Git リポジトリーパスを選択し、そのリポジトリーがプライベートの場合は、接続情報を指定する必要がありません。接続情報が事前設定されているため、これらの値を確認する必要はありません。

- 新しい Git リポジトリーパスを入力し、その Git リポジトリーがプライベートの場合は、オプションで Git 接続情報を入力できます。

-

調整オプションに着目します。

mergeオプションは、新規フィールドが追加され、既存フィールドがリソースで更新されることを意味するデフォルトの選択です。replaceを選択することができます。replaceオプションを指定すると、既存のリソースが Git ソースに置き換えられます。サブスクリプションの調整速度をlowに設定すると、サブスクライブしているアプリケーションリソースの調整に最大 1 時間かかる場合があります。単一アプリケーションビューのカードで、Sync をクリックして手動で調整します。offに設定すると、調整はありません。

-

デプロイメントの前後のタスクをオプションで設定します。サブスクリプションがアプリケーションリソースをデプロイする前または後に実行する Ansible Automation Platform ジョブがある場合は、Ansible Automation Platform シークレットを設定します。ジョブを定義する Ansible Automation Platform タスクは、このリポジトリーの

prehookおよびposthookフォルダー内に配置する必要があります。 - コンソールを使用して認証情報を追加する必要がある場合は、Add credential をクリックします。コンソールの指示に従います。詳細は、認証情報の管理の概要 を参照してください。

- Create をクリックします。

- Overview ページにリダイレクトされ、詳細とトポロジーを確認できます。

1.4.1.1. GitOps パターン

Git リポジトリーを編成してクラスターを管理するベストプラクティスについて説明します。

1.4.1.1.1. GitOps のサンプルディレクトリー

この例のフォルダーは定義されて名前が付けられ、各フォルダーには、マネージドクラスターで実行されるアプリケーションまたは設定が含まれます。

-

root フォルダー

managed-subscriptions:common-managedフォルダーをターゲットとするサブスクリプションが含まれます。 -

サブフォルダー

apps/:managed-clustersに対する配置でcommon-managedフォルダーでアプリケーションをサブスクライブするために使用されます。 -

サブフォルダー

config/:managed-clustersに対する配置でcommon-managedフォルダーで設定をサブスクライブするために使用されます。 -

サブフォルダー

policies/:managed-clustersに対する配置でポリシーを適用するために使用します。 -

フォルダー

root-subscription/:managed-subscriptionsフォルダーをサブスクライブするハブクラスターの最初のサブスクリプション。

ディレクトリーの例を参照してください。

1.4.1.1.2. GitOps フロー

ディレクトリー構造は、root-subscription > managed-subscriptions > common-managed のサブスクリプションフロー用に作成されます。

-

root-subscription/の単一サブスクリプションは、CLI ターミナルからハブクラスターに適用されます。 サブスクリプションとポリシーは、

managed-subscriptionフォルダーからハブクラスターにダウンロードされ、適用されます。-

managed-subscriptionフォルダーのサブスクリプションおよびポリシーは、配置に基づいてマネージドクラスターで機能します。 -

配置は、各サブスクリプションまたはポリシーが影響を及ぼす

managed-clustersを決定します。 - サブスクリプションまたはポリシーは、配置に一致するクラスター上のものを定義します。

-

-

サブスクリプションは、

common-managedフォルダーのコンテンツを、配置ルールに一致するmanaged-clustersに適用します。また、配置ルールに一致するすべてのmanaged-clustersに対して、一般的なアプリケーションおよび設定も適用されます。

1.4.1.1.3. その他の例

-

root-subscription/の例は、application-subscribe-allを参照してください。 -

同じリポジトリーにある他のフォルダーを参照するサブスクリプションの例は、

subscribe-allを参照してください。 -

nginx-appsリポジトリーのアプリケーションアーティファクトを含むcommon-managedフォルダーの例を参照してください。 - Policy collection のポリシーの例を参照してください。

1.4.1.2. Git でサブスクリプションを削除した後、デプロイされたリソースを保持する

Git リポジトリーを使用してサブスクリプションを作成する場合、do-not-delete アノテーションを追加して、サブスクリプションを削除した後も特定のデプロイ済みリソースを保持できます。do-not-delete アノテーションは、最上位のデプロイリソースでのみ機能します。do-not-delete アノテーションを追加するには、次の手順を実行します。

- 少なくとも 1 つのリソースをデプロイするサブスクリプションを作成します。

サブスクリプションを削除した後でも、保持するリソースに次のアノテーションを追加します。

apps.open-cluster-management.io/do-not-delete: 'true'以下の例を参照してください。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

サブスクリプションを削除した後、do-not-delete アノテーションを持つリソースは引き続き存在しますが、他のリソースは削除されます。

注記: do-not-delete アノテーションを使用してデプロイされたままのリソースは、namespace にバインドされます。そのため、残りのリソースを削除するまで namespace を削除することはできません。

1.4.2. Helm リポジトリーを使用したアプリケーションの管理

アプリケーションを使用して Kubernetes リソースをデプロイする場合に、リソースは特定のリポジトリーに配置されます。以下の手順で、Helm リポジトリーからリソースをデプロイする方法を説明します。アプリケーションモデルおよび定義 でアプリケーションモデルを確認してください。

ユーザーに必要なアクセス権: アプリケーションを作成できるユーザーロールロールが割り当てられているアクションのみを実行できます。ロールベースのアクセス制御 のドキュメントで、アクセス要件を確認してください。

- コンソールのナビゲーションメニューから Applications をクリックし、リスト表示されているアプリケーションを表示して新規アプリケーションを作成します。

- オプション: 作成するアプリケーションの種類を選択した後に、YAML: On を選んで YAML: アプリケーションの作成および編集時に YAML をコンソールで表示できます。このトピックの後半にある YAML サンプルを参照してください。

- 使用できるリポジトリーのリストから Helm を選択し、正しいフィールドに値を入力します。コンソールのガイダンスに従い、入力に基づいて YAML エディターの変更値を確認します。

- Create をクリックします。

- Overview ページにリダイレクトされ、詳細とトポロジーを確認できます。

1.4.2.1. YAML 例

以下のチャネル定義例では Helm リポジトリーをチャネルとして抽象化します。

注記: Helm では、Helm チャートに含まれる全 Kubernetes リソースにはラベルリリースが必要です。アプリケーショントポロジーの {{ .Release.Name }}` が正しく表示されるようにします。

以下のチャネル定義は、Helm リポジトリーチャネルの別の例を示しています。

注記: REST API を確認するには、API を使用してください。

1.4.2.2. Helm でサブスクリプションを削除した後、デプロイされたリソースを保持する

Helm は、サブスクリプションを削除した後、特定のデプロイされたリソースを保持するためのアノテーションを提供します。詳細は、Tell Helm Not To Uninstall a Resource を参照してください。

注記: アノテーションは Helm チャートにある必要があります。

1.4.3. Object Storage リポジトリーを使用したアプリケーションの管理

アプリケーションを使用して Kubernetes リソースをデプロイする場合に、リソースは特定のリポジトリーに配置されます。アプリケーションモデルおよび定義 でアプリケーションモデルを確認してください。

ユーザーに必要なアクセス権: アプリケーションを作成できるユーザーロールロールが割り当てられているアクションのみを実行できます。ロールベースのアクセス制御 のドキュメントで、アクセス要件を確認してください。

- コンソールのナビゲーションメニューから Applications をクリックし、リスト表示されているアプリケーションを表示して新規アプリケーションを作成します。

- オプション: 作成するアプリケーションの種類を選択した後に、YAML: On を選んで YAML: アプリケーションの作成および編集時に YAML をコンソールで表示できます。このトピックの後半にある YAML サンプルを参照してください。

- 使用できるリポジトリーのリストから オブジェクトストア を選択し、正しいフィールドに値を入力します。コンソールのガイダンスに従い、入力に基づいて YAML エディターの変更値を確認します。

- Create をクリックします。

- Overview ページにリダイレクトされ、詳細とトポロジーを確認できます。

1.4.3.1. YAML 例

以下のチャネル定義例では、オブジェクトストレージをチャネルとして抽象化します。

注記: REST API を確認するには、API を使用します。

1.4.3.2. Amazon Web Services (AWS) S3 オブジェクトストレージバケットの作成

サブスクリプションを設定して、Amazon Simple Storage Service (Amazon S3) オブジェクトストレージサービスで定義したリソースをサブスクライブできます。以下の手順を参照してください。

- AWS アカウント、ユーザー名、およびパスワードを使用して AWS コンソール にログインします。

- Amazon S3 > Buckets に移動し、バケットホームページに移動します。

- Create Bucket をクリックし、バケットを作成します。

- AWS リージョン を選択します。AWS S3 オブジェクトバケットの接続に不可欠です。

- バケットアクセストークンを作成します。

- ナビゲーションバーのユーザー名に移動して、ドロップダウンメニューから My Security Credentials を選択します。

- AWS IAM credentials タブで Access keys for CLI, SDK, & API access に移動し、Create access key をクリックします。

- Access key ID と Secret access key を保存します。

- オブジェクト YAML ファイルをバケットにアップロードします。

1.4.3.3. AWS バケットのオブジェクトへのサブスクライブ

- シークレットでオブジェクトバケットタイプチャネルを作成し、AccessKeyID、SecretAccessKey、および リージョン を指定して、AWS バケットに接続します。AWS バケットの作成時に、この 3 つのフィールドが作成されます。

URL を追加します。URL に

s3://またはs3 and awsのキーワードが含まれる場合は、その URL で AWS S3 バケットのチャネルを特定します。たとえば、以下のバケット URL にはすべて AWS s3 バケット識別子が含まれます。https://s3.console.aws.amazon.com/s3/buckets/sample-bucket-1 s3://sample-bucket-1/ https://sample-bucket-1.s3.amazonaws.com/

https://s3.console.aws.amazon.com/s3/buckets/sample-bucket-1 s3://sample-bucket-1/ https://sample-bucket-1.s3.amazonaws.com/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記: バケットを AWS S3 API に接続する場合に、AWS S3 オブジェクトバケット URL は必要ありません。

1.4.3.4. AWS サブスクリプションの例

以下の完全な AWS S3 オブジェクトバケットチャネルのサンプル YAML ファイルを参照してください。

以下の YAML の例で kind: PlacementRule および kind: Subscription added と表示されているため、引き続き他の AWS サブスクリプションおよび配置ルールオブジェクトを作成できます。

オブジェクトバケットの特定サブフォルダー内にあるオブジェクトをサブスクライブすることもできます。subfolder アノテーションをサブスクリプションに追加することで、オブジェクトバケットサブスクリプションがサブフォルダーパス内の全リソースのみを強制的に適用します。

subfolder-1 のアノテーションを bucket-path として参照してください。

annotations: apps.open-cluster-management.io/bucket-path: <subfolder-1>

annotations:

apps.open-cluster-management.io/bucket-path: <subfolder-1>サブフォルダーの完全なサンプルは、以下を参照してください。

1.4.3.5. オブジェクトストレージでサブスクリプションを削除した後、デプロイされたリソースを保持する

オブジェクトストレージリポジトリーを使用してサブスクリプションを作成する場合、do-not-delete アノテーションを追加して、サブスクリプションを削除した後も特定のデプロイ済みリソースを保持できます。do-not-delete アノテーションは、最上位のデプロイリソースでのみ機能します。do-not-delete アノテーションを追加するには、次の手順を実行します。

- 少なくとも 1 つのリソースをデプロイするサブスクリプションを作成します。

サブスクリプションを削除した後でも、保持するリソースに次のアノテーションを追加します。

apps.open-cluster-management.io/do-not-delete: 'true'以下の例を参照してください。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

サブスクリプションを削除した後、do-not-delete アノテーションを持つリソースは引き続き存在しますが、他のリソースは削除されます。

注記: do-not-delete アノテーションを使用してデプロイされたままのリソースは、namespace にバインドされます。そのため、残りのリソースを削除するまで namespace を削除することはできません。

1.5. Ansible Automation Platform の統合と導入

Red Hat Advanced Cluster Management は Red Hat Ansible Automation Platform と統合されているため、Git サブスクリプションアプリケーション管理用のプリフックおよびポストフック AnsibleJob インスタンスを作成できます。コンポーネントと Ansible Automation Platform の設定方法を学びます。

必要なアクセス権: クラスター管理者

1.5.1. 統合とコンポーネント

Ansible Automation Platform ジョブを Git サブスクリプションに統合できます。たとえば、データベースのフロントエンドおよびバックエンドアプリケーションの場合、Ansible Automation Platform ジョブで Ansible Automation Platform を使用してデータベースをインスタンス化する必要があります。アプリケーションは、Git サブスクリプションによってインストールされます。サブスクリプションを使用してフロントエンドおよびバックエンドアプリケーションをデプロイする 前 に、データベースはインスタンス化されます。

アプリケーションのサブスクリプション Operator は、prehook および posthook の 2 つのサブフォルダーを定義できるように強化されています。いずれのフォルダーも Git リポジトリーリソースのルートパスにあり、それぞれ Ansible Automation Platform ジョブのプリフックおよびポストフックがすべて含まれています。

Git サブスクリプションが作成されると、プリフックおよびポストフックのすべての AnsibleJob のリソースがすべて解析され、オブジェクトとしてメモリーに保存されます。アプリケーションのサブスクリプションコントローラーは、プリフックおよびポストフックの AnsibleJob インスタンスを作成するタイミングを決定します。

サブスクリプションカスタムリソースを作成すると、Git ブランチおよび Git パスは Git リポジトリーのルートの場所を参照します。Git のルート内の 2 つのサブフォルダー (prehook および posthook) には最低でも Kind:AnsibleJob リソース 1 つが含まれている必要があります。

1.5.1.1. Prehook

アプリケーションサブスクリプションコントローラーは、プリフックフォルダー内のすべての kind:AnsibleJob CR をプリフックの AnsibleJob オブジェクトとして検索し、新しいプリフックの AnsibleJob インスタンスを生成します。新しいインスタンス名はプリフックの AnsibleJob オブジェクト名とランダムな接尾辞文字列です。

インスタンス名の例 database-sync-1-2913063 を参照してください。

アプリケーションサブスクリプションコントローラーは、調整要求を 1 分間のループで再度キューに追加します。プリフックの AnsibleJob status.AnsibleJobResult をチェックします。プリフックステータスが successful の場合、アプリケーションサブスクリプションは主要なサブスクリプションを引き続きデプロイします。

1.5.1.2. posthook

アプリケーションのサブスクリプションステータスが更新されると、サブスクリプションのステータスが Subscribed か、ステータスが Subscribed の全ターゲットクラスターに伝播された場合に、アプリケーションのサブスクリプションコントローラーは posthook AnsibleJob オブジェクトとして、posthook フォルダーの全 AnsibleJob kind CR を検索します。次に、posthook AnsibleJob インスタンスを新たに生成します。新しいインスタンス名には、posthook AnsibleJob のオブジェクト名、その後に無作為に指定した接尾辞の文字列を指定します。

インスタンス名の例 service-ticket-1-2913849 を参照してください。

1.5.1.3. Ansible Automation Platform の配置ルール

有効なプリフックの AnsibleJob では、サブスクリプションは配置ルールの決定事項に関係なく、プリフックの AnsibleJob を起動します。

たとえば、配置ルールサブスクリプションの伝播に失敗したプリフックの AnsibleJob を起動できます。配置ルールの意思決定が変更すると、新しいプリフックおよびポストフックの AnsibleJob インスタンスが作成されます。

{aap_short} を有効にするには、次のトピックを参照してください。

1.5.2. Ansible Automation Platform のセットアップ

Ansible Automation Platform ジョブを使用すると、タスクを自動化し、Slack や PagerDuty サービスなどの外部サービスと統合できます。Git リポジトリーのリソースルートパスには、アプリケーションのデプロイ、アプリケーションの更新、またはクラスターからのアプリケーションの削除の一部として実行される Ansible Automation Platform ジョブの prehook および posthook ディレクトリーが含まれます。

必要なアクセス権: クラスター管理者

1.5.2.1. 前提条件

- OpenShift Container Platform 4.6 以降をインストールします。

- Ansible Automation Platform をインストールします。サポートされている最新バージョンをインストールするには、Red Hat Ansible Automation Platform ドキュメントを参照してください。

- Ansible Automation Platform Resource Operator をインストールして、Ansible Automation Platform ジョブを Git サブスクリプションのライフサイクルに接続する。ベストプラクティス: Ansible Automation Platform ジョブテンプレートは、実行時、べき等である必要があります。

-

INVENTORYとEXTRA VARIABLESの両方について、テンプレートのPROMPT ON LAUNCHを確認する。詳細は、Job templates を参照してください。

1.5.2.2. Ansible Automation Platform Resource Operator のインストール

- OpenShift Container Platform クラスターコンソールにログインします。

- コンソールナビゲーションで OperatorHub をクリックします。

Ansible Automation Platform Resource Operator を検索し、インストールします。注記: プリフックおよびポストフックの

AnsibleJobsを送信するには、Red Hat Ansible Automation Platform Resource Operator を以下の OpenShift Container Platform バージョンで利用可能な対応するバージョンとともにインストールします。- OpenShift Container Platform 4.8 には (AAP) リソース Operator の早期アクセス、stable-2.1、stable-2.2 が必要です

- OpenShift Container Platform 4.9 には (AAP) リソース Operator の早期アクセス、stable-2.1、stable-2.2 が必要です

- OpenShift Container Platform 4.10 以降には、(AAP) Resource Operator stable-2.1、stable-2.2 が必要です。

その後、コンソールの Credentials ページから認証情報を作成できます。Add credential をクリックするか、ナビゲーションからページにアクセスします。認証情報は、Ansible Automation Platform の認証情報の作成 を参照してください。

1.5.3. Ansible Automation Platform の設定

With {aap-short} jobs, you can automate tasks and integrate with external services, such as Slack and PagerDuty services. Your Git repository resource root path will contain `prehook` and `posthook` directories for {aap-short} jobs that run as part of deploying the application, updating the application, or removing the application from a cluster.

With {aap-short} jobs, you can automate tasks and integrate with external services, such as Slack and PagerDuty services. Your Git repository resource root path will contain `prehook` and `posthook` directories for {aap-short} jobs that run as part of deploying the application, updating the application, or removing the application from a cluster.必要なアクセス権: クラスター管理者

Ansible Automation Platform 設定は、以下のタスクで行うことができます。

1.5.3.1. Ansible Automation Platform シークレットの設定

Ansible Automation Platform シークレットカスタムリソースを同じサブスクリプション namespace に作成する必要があります。Ansible Automation Platform シークレットは、同じサブスクリプション namespace に制限されています。

Ansible Automation Platform secret nameセクションに入力して、コンソールからシークレットを作成します。ターミナルを使用してシークレットを作成するには、サンプルのyamlファイルを編集して適用します。注記:

namespaceは、サブスクリプションの namespace と同じにします。stringData:tokenとhostは、Ansible Automation Platform のものです。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して YAML ファイルを追加します。

oc apply -f

oc apply -fCopy to Clipboard Copied! Toggle word wrap Toggle overflow

アプリケーションサブスクリプションコントローラーがプリフックおよびポストフックの Ansible ジョブを作成する際、サブスクリプション spec.hooksecretref からのシークレットが利用可能な場合、それは AnsibleJob カスタムリソース spec.tower_auth_secret に送信され、AnsibleJob は Ansible Automation Platform にアクセスできます。

1.5.3.2. シークレット調整の設定

プリフックおよびポストフックの AnsibleJob を使用するメインのサブサブスクリプションの場合、すべてのプリフックおよびポストフックの AnsibleJob またはメインのサブスクリプションが Git リポジトリーで更新された後、メイン/サブのサブスクリプションを調整する必要があります。

プリフックの AnsibleJob とメインのサブスクリプションは新しいプリフックの AnsibleJob インスタンスを継続的に調整および再起動します。

-

プリフックの

AnsibleJobが完了したら、メインのサブスクリプションを再実行します。 - メインのサブスクリプションに仕様変更がある場合は、サブスクリプションを再デプロイします。再デプロイメントの手順に合わせて、メインのサブスクリプションステータスを更新する必要があります。

ハブクラスターのサブスクリプションステータスを

nilにリセットします。サブスクリプションは、ターゲットクラスターにサブスクリプションをデプロイするときに合わせて更新されます。ターゲットクラスターへのデプロイメントが終了すると、ターゲットクラスターのサブスクリプションステータスが

"subscribed"または"failed"になり、ハブクラスターのサブスクリプションステータスに同期されます。-

メインのサブスクリプションが完了したら、新しいポストフックの

AnsibleJobインスタンスを再起動します。 サブスクリプションが更新されていることを確認します。以下の出力を参照してください。

-

subscription.status ==

"subscribed" -

subscription.status ==

"propagated"with all of the target clusters"subscribed"

-

subscription.status ==

AnsibleJob カスタムリソースが作成されると、ターゲットの Ansible Automation Platform と通信することによって、Ansible Automation Platform ジョブを起動するために、Kubernetes ジョブのカスタムリソースが作成されます。ジョブが完了すると、ジョブの最終ステータスが AnsibleJob status.AnsibleJob Result に戻ります。

注記:

AnsibleJob status.conditions は、Kubernetes ジョブの結果の作成を保存するために、Ansible Automation Platform Job Operator によって予約されています。status.conditions は実際の Ansible Automation Platform ジョブのステータスを反映していません。

サブスクリプションコントローラーは、AnsibleJob.status.conditions ではなく、AnsibleJob.status.AnsibleJob.Result によって、Ansible Automation Platform ジョブのステータスをチェックします。

プリフックおよびポストフックの AnsibleJob ワークフローで前述したように、メインのサブスクリプションが Git リポジトリーで更新されると、新しいプリフックおよびポストフックの AnsibleJob インスタンスが作成されます。その結果、1 つのメインサブスクリプションが複数の AnsibleJob インスタンスにリンクできます。

subscription.status.ansiblejobs には、4 つのフィールドが定義されています。

-

lastPrehookJobs: 最新のプリフックの Ansible ジョブ -

prehookJobsHistory: プリフックの Ansible ジョブのすべての履歴 -

lastPosthookJobs: 最新のポストフックの Ansible ジョブ -

posthookJobsHistory: ポストフックの Ansible ジョブのすべての履歴

1.5.3.3. Ansible Automation Platform サンプル YAML ファイルの使用

Git prehook および posthook フォルダー内の AnsibleJob YAML ファイルの次のサンプルを参照してください。

1.5.3.4. ワークフローの起動

AnsibleJob カスタムリソースを使用して Ansible Automation Platform ワークフローを起動するには、次の例に示すように、job_template_name フィールドを workflow_template_name に置き換えます。

1.5.3.5. Ansible Automation Platform のサンプル YAML ワークフローの使用

Git prehook および posthook フォルダー内の Workflow AnsibleJob YAML ファイルの次のサンプルを参照してください。

Ansible ワークフローの詳細は、ワークフロー を参照してください。

1.6. アプリケーションの詳細設定

Red Hat Advanced Cluster Management for Kubernetes では、アプリケーションは複数のアプリケーションリソースで設定されています。チャネル、サブスクリプション、配置、および配置ルールリソースを使用すると、アプリケーション全体のデプロイ、更新、および管理に役立ちます。

単一クラスターアプリケーションもマルチクラスターアプリケーションも同じ Kubernetes 仕様を使用しますが、マルチクラスターアプリケーションでは、デプロイメントおよびアプリケーション管理ライフサイクルがさらに自動化されます。

Red Hat Advanced Cluster Management for Kubernetes アプリケーションのアプリケーションコンポーネントリソースはすべて、YAML ファイルの仕様セクションで定義します。アプリケーションコンポーネントリソースを作成または更新する必要がある場合は、適切な仕様セクションを作成してリソースを定義するラベルを追加する必要があります。

以下のアプリケーション詳細設定のトピックを確認してください。

- Git リソースのサブスクライブ

- サブスクリプション特権の付与

- サブスクリプション管理者としての許可リストの作成および拒否リストの作成

- 調整オプションの追加

- リーダー選択の設定

- セキュアな Git 接続用のアプリケーションチャネルおよびサブスクリプションの設定

- Ansible Automation Platform タスクのセットアップ

- namespace リソースを監視するように Helm を設定する

- マネージドクラスターでの GitOps の設定

- Push と Pull モデルを使用した Argo CD の導入

- パッケージの上書きの設定

- チャネルサンプルの概要

- サブスクリプションの例の概要

- 配置ルールの例の概要

- アプリケーションの例の概要

1.6.1. Git リソースのサブスクライブ

デフォルトでは、サブスクリプションを使用してサブスクライプされているアプリケーションをターゲットクラスターにデプロイすると、アプリケーションリソースが別の namespace に関連付けられている場合でも、このアプリケーションはこのサブスクリプション namespace にデプロイされます。サブスクリプションの管理権限の付与 で説明されているように、サブスクリプション管理者 はデフォルトの動作を変更できます。

また、アプリケーションリソースがクラスターに存在しており、サブスクリプションを使用して作成されていない場合、このサブスクリプションではその既存リソースに対して新しいリソースを適用できません。サブスクリプション管理者としてデフォルト設定を変更するには、以下のプロセスを参照してください。

必要なアクセス権限: クラスターの管理者

1.6.1.1. Git でのアプリケーションリソースの作成

サブスクライブ時に、リソース YAML で apiVersion の完全グループおよびバージョンを指定する必要があります。たとえば、apiVersion: v1 にサブスクライブすると、サブスクリプションコントローラーがサブスクリプションの検証に失敗し、エラーメッセージ Resource /v1, Kind=ImageStream is not supported が表示されます。

以下の例にあるように、apiVersion を image.openshift.io/v1 に変更すると、サブスクリプションコントローラーの検証を渡し、リソースが正常に適用されます。

次に、サブスクリプション管理者がデフォルト動作を変更する有用な例を確認します。

1.6.1.2. アプリケーション namespace の例

以下の例では、サブスクリプション管理者としてログインします。

1.6.1.2.1. アプリケーションと異なる namespace

サブスクリプションを作成して、サンプルのリソース YAML ファイルを Git リポジトリーからサブスクライブします。このサンプルファイルには、以下の異なる namespace にあるサブスクリプションが含まれます。

適用可能なチャネルタイプ: Git

-

ConfigMap

test-configmap-1はmultinsnamespace に作成されます。 -

ConfigMap

test-configmap-2はdefaultnamespace に作成されます。 ConfigMap

test-configmap-3はsubscriptionnamespace に作成されます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

他のユーザーがサブスクリプションを作成した場合は、ConfigMap がすべて、サブスクリプションと同じ namespace に作成されます。

1.6.1.2.2. 同じ namespace へのアプリケーション

サブスクリプション管理者は、すべてのアプリケーションリソースを同じ namespace にデプロイする必要がある場合があります。

サブスクリプション管理者として許可リストと拒否リストを作成する ことにより、すべてのアプリケーションリソースをサブスクリプション namespace にデプロイできます。

apps.open-cluster-management.io/current-namespace-scoped: true アノテーションをサブスクリプション YAML に追加します。たとえば、サブスクリプション管理者が以下のサブスクリプションを作成すると、直前の例の 3 つの ConfigMap すべてが subscription-ns namespace に作成されます。

1.6.1.3. リソース上書きの例

適用可能なチャネルタイプ: Git、ObjectBucket (コンソールのオブジェクトストレージ)

注記: helm チャートリソースが Helm で管理されているため、リソースの上書きオプションは Git リポジトリーから helm チャートには適用されません。

この例では、以下の ConfigMap はすでにターゲットクラスターにあります。

Git リポジトリーから、以下のリソース YAML ファイル例をサブスクライブして、既存の ConfigMap を置き換えます。data 仕様の変更を参照してください。

1.6.1.3.1. デフォルトのマージオプション

デフォルトの apps.open-cluster-management.io/reconcile-option: merge アノテーションを使用して、Git リポジトリーから以下のサンプルリソースの YAML ファイルを表示します。以下の例を参照してください。

サブスクリプション管理者がこのサブスクリプションを作成し、そのサブスクリプションで ConfigMap リソースをサブスクライブする場合は、以下の例のように既存の ConfigMap をマージします。

merge オプションを使用すると、サブスクライブしているリソースのエントリーが、既存のリソースで作成または更新されます。既存のリソースからエントリーは削除されません。

重要: サブスクリプションで上書きする既存のリソースが自動的に別の Operator またはコントローラーで調整されると、リソース設定はサブスクリプションとコントローラーの両方、または Operator により更新されます。このような場合は、この方法を使用しないでください。

1.6.1.3.2. mergeAndOwn オプション

mergeAndOwn では、サブスクライブしているリソースのエントリーが既存のリソースで作成または更新されます。サブスクリプション管理者としてログインして、apps.open-cluster-management.io/reconcile-option: mergeAndOwn アノテーションを付けてサブスクリプションを作成します。以下の例を参照してください。

サブスクリプション管理者がこのサブスクリプションを作成し、そのサブスクリプションで ConfigMap リソースをサブスクライブする場合は、以下の例のように既存の ConfigMap をマージします。

前述のように、mergeAndOwn オプションを使用すると、サブスクライブしているリソースのエントリーが既存のリソースで作成または更新されます。既存のリソースからエントリーは削除されません。また、apps.open-cluster-management.io/hosting-subscription アノテーションを追加して、リソースがサブスクリプションによって所有されていることを示します。サブスクリプションを削除すると、ConfigMap が削除されます。

1.6.1.3.3. replace オプション

サブスクリプション管理者としてログインして、apps.open-cluster-management.io/reconcile-option: replace アノテーションを付けてサブスクリプションを作成します。以下の例を参照してください。

サブスクリプション管理者がこのサブスクリプションを作成し、そのサブスクリプションで ConfigMap リソースをサブスクライブする場合は、既存の ConfigMap を以下に置き換えます。

1.6.1.4. 特定の Git 要素のサブスクライブ

特定の Git ブランチ、コミット、またはタグをサブスクライブできます。

1.6.1.4.1. 特定のブランチへのサブスクライブ

multicloud-operators-subscription リポジトリーに含まれるサブスクリプション operator は、デフォルトで Git リポジトリーのデフォルトのブランチにサブスクライブします。別のブランチにサブスクライブする場合は、そのサブスクリプションにブランチ名のアノテーションを指定する必要があります。

以下の YAML ファイルの例では apps.open-cluster-management.io/git-branch: <branch1> で異なるブランチを指定する方法を示しています。

1.6.1.4.2. 特定のコミットのサブスクライブ

multicloud-operators-subscription リポジトリーに含まれるサブスクリプション operator は、デフォルトで Git リポジトリーの指定のブランチに対する最新のコミットにサブスクライブします。特定のコミットにサブスクライブする場合は、サブスクリプションのコミットハッシュで、必要なコミットアノテーションを指定する必要があります。

以下の YAML ファイルの例では apps.open-cluster-management.io/git-desired-commit: <full commit number> で異なるコミットを指定する方法を示しています。

git-clone-depth アノテーションは任意で、デフォルトでは 20 に設定されます。この値は、サブスクリプションコントローラーが Git リポジトリーから最新のコミット履歴 20 回分を取得するという意味です。随分前の git-desired-commit を指定する場合は、必要なコミットに合った git-clone-depth を指定する必要があります。

1.6.1.4.3. 特定のタグへのサブスクライブ

multicloud-operators-subscription リポジトリーに含まれるサブスクリプション operator は、デフォルトで Git リポジトリーの指定のブランチに対する最新のコミットにサブスクライブします。特定のタグをサブスクライブする場合は、サブスクリプションにタグのアノテーションを指定する必要があります。

以下の YAML ファイルの例では apps.open-cluster-management.io/git-tag: <v1.0> で異なるタグを指定する方法を示しています。

注記: Git のコミットとタグアノテーションの両方が指定された場合は、タグが無視されます。

git-clone-depth アノテーションは任意で、デフォルトでは 20 に設定されます。この値は、サブスクリプションコントローラーが Git リポジトリーから最新のコミット履歴 20 回分を取得するという意味です。随分前の git-tag を指定する場合は、必要なタグのコミットに合った git-clone-depth を指定する必要があります。

1.6.2. サブスクリプション管理者権限の付与

サブスクリプションの管理者権限を付与する方法を説明します。サブスクリプション 管理者は、デフォルトの動作を変更できます。詳細は、以下のプロセスを参照してください。

- コンソールから OpenShift Container Platform クラスターにログインします。

ユーザーを 1 つ以上作成します。ユーザー作成に関する詳細は、ユーザー向けの準備 を参照してください。グループまたはサービスアカウントを用意することもできます。

app.open-cluster-management.io/subscriptionアプリケーションの管理者として、ユーザーを作成します。OpenShift Container Platform では、サブスクリプション 管理者はデフォルトの動作を変更できます。これらのユーザーをグループ化してサブスクリプション管理グループを表すことができます。これは、後ほど例説します。- ターミナルから、Red Hat Advanced Cluster Management クラスターにログインします。

open-cluster-management:subscription-adminClusterRoleBinding が存在しない場合は作成する必要があります。以下の例を参照してください。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドで、次のサブジェクトを

open-cluster-management:subscription-adminClusterRoleBinding に追加します。oc edit clusterrolebinding open-cluster-management:subscription-admin

oc edit clusterrolebinding open-cluster-management:subscription-adminCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記:

open-cluster-management:subscription-adminClusterRoleBinding にはサブジェクトは初期設定されていません。サブジェクトは以下の例のように表示されます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Service Account は、ユーザーサブジェクトとして使用できます。

1.6.3. サブスクリプション管理者としての許可リストの作成および拒否リストの作成

サブスクリプション管理者は、Git リポジトリーアプリケーションのサブスクリプションからアプリケーションを作成し、allow リストを使用して、指定された Kubernetes kind リソースのみのデプロイメントを可能にします。アプリケーションサブスクリプションに deny list を作成して、特定の Kubernetes kind リソースのデプロイメントを拒否することもできます。

デフォルトでは、policy.open-cluster-management.io/v1 リソースはアプリケーションサブスクリプションによってデプロイされません。このデフォルトの動作を回避するには、サブスクリプション管理者がアプリケーションサブスクリプションをデプロイする必要があります。

以下の allow および deny 仕様の例を参照してください。

以下のアプリケーションサブスクリプション YAML は、ソースリポジトリーの myapplication ディレクトリーからアプリケーションがデプロイされると、ソースリポジトリーに他のリソースがある場合でも v1/Deployment リソースのみをデプロイすることを指定します。

このアプリケーションのサブスクリプション YAML は、v1/Service および v1/ConfigMap リソース以外のすべての有効なリソースのデプロイを指定します。API グループ内に個別のリソースの種類をリスト表示する代わりに、"*" を追加して、API グループのすべてのリソースの種類を許可または拒否できます。

1.6.4. 調整オプションの追加

個々のリソースで apps.open-cluster-management.io/reconcile-option アノテーションを使用して、サブスクリプションレベルの調整オプションを上書きできます。

たとえば、apps.open-cluster-management.io/reconcile-option: replace アノテーションをサブスクリプションに追加し、サブスクライブされた Git リポジトリーのリソース YAML に apps.open-cluster-management.io/reconcile-option: merge アノテーションを追加すると、そのリソースはターゲットクラスターにマージされます。その他のリソースは置き換えられます。

1.6.4.1. 調整頻度の Git チャネル

チャネル設定で、不要なリソースの調整を回避するために調整頻度オプション (high、medium、low、および off) を選択できるようになりました。これにより、サブスクリプション Operator のオーバーロードを防ぐことができます。

必要なアクセス: 管理者およびクラスター管理者である必要があります。

settings:attribute:<value> に関する以下の定義を参照してください。

-

Off: デプロイされたリソースは自動的に調整されません。Subscriptionカスタムリソースを変更すると、調整がトリガーされます。ラベルまたはアノテーションを追加または更新できます。 -

Low: ソースの Git リポジトリーに変更がない場合でも、デプロイされたリソースは 1 時間ごとに自動調整されます。 -

Medium: これはデフォルトの設定です。サブスクリプション Operator は、3 分ごとに現在デプロイされているコミット ID をソースリポジトリーの最新コミット ID と比較し、ターゲットクラスターに変更を適用します。リポジトリーに変更がない場合でも、すべてのリソースは 15 分ごとにソース Git リポジトリーからターゲットクラスターに再適用されます。 -

High: ソースの Git リポジトリーに変更がない場合でも、デプロイされたリソースは 2 分ごとに自動調整されます。

これは、サブスクリプションによって参照されるチャネルカスタムリソースの apps.open-cluster-management.io/reconcile-rate アノテーションを使用して設定できます。

name: git-channel の例を参照してください。

上記の例では、sample/git-channel を使用するすべてのサブスクリプションの調整頻度は low に割り当てられます。

-

サブスクリプションの調整速度を

lowに設定すると、サブスクライブしているアプリケーションリソースの調整に最大 1 時間かかる場合があります。単一アプリケーションビューのカードで、Sync をクリックして手動で調整します。offに設定すると、調整はありません。

チャネルの reconcile-rate 設定に関係なく、サブスクリプションは、Subscription カスタムリソースの apps.open-cluster-management.io/reconcile-rate: off アノテーションを指定して、自動調整を off に設定できます。

以下の git-channel の例を参照してください。

チャネルで reconcile-rate が high に設定されている場合でも、git-subscription によってデプロイされたリソースが自動調整されないことを確認します。

1.6.4.2. Helm チャネルの調整頻度

サブスクリプション Operator は 15 分ごとに、Helm チャートで現在デプロイされているハッシュを、ソースリポジトリーからのハッシュと比較します。変更がターゲットクラスターに適用されます。リソース調整の頻度は、他のアプリケーションのデプロイメントおよび更新のパフォーマンスに影響します。

たとえば、数百のアプリケーションサブスクリプションがあり、すべてのサブスクリプションを頻繁に調整する場合は、調整の応答時間は遅くなります。

アプリケーションの Kubernetes リソースによっては、適切な調整頻度でパフォーマンスを向上できます。

-

Off: デプロイされたリソースは自動的に調整されません。サブスクリプションカスタムリソースを変更すると、調整がトリガーされます。ラベルまたはアノテーションを追加または更新できます。 -

Low: サブスクリプション Operator は、1 時間ごとに現在デプロイされているハッシュと、ソースリポジトリーのハッシュと比較し、変更がある場合はターゲットクラスターに変更を適用します。 -

Medium: これはデフォルトの設定です。サブスクリプション Operator は、15 分ごとに現在デプロイされているハッシュと、ソースリポジトリーのハッシュと比較し、変更がある場合はターゲットクラスターに変更を適用します。 -

High: サブスクリプション Operator は、2 分ごとに現在デプロイされているハッシュと、ソースリポジトリーのハッシュと比較し、変更がある場合はターゲットクラスターに変更を適用します。

これは、サブスクリプションによって参照される Channel カスタムリソースの apps.open-cluster-management.io/reconcile-rate アノテーションを使用して設定できます。以下の helm-channel の例を参照してください。

以下の helm-channel の例を参照してください。

この例では、sample/helm-channel を使用するすべてのサブスクリプションの調整頻度は low になります。

チャネルの reconcile-rate 設定に関係なく、サブスクリプションは、Subscription カスタムリソースの apps.open-cluster-management.io/reconcile-rate: off アノテーションを指定して、自動調整を off に設定できます。

この例では、チャネルで reconcile-rate が high に設定されている場合でも、helm-subscription によってデプロイされたリソースが自動調整されないことを確認します。

1.6.5. リーダー選択の設定

LeaderElection を使用すると、障害が発生した場合にコントローラーが新しいリーダーを選択するようにリクエストする方法を変更できます。これにより、一度に 1 つのリーダーインスタンスのみが調整を処理することが保証されます。コントローラーが LeaderElection を取得するのにかかる時間を増減できます。時間が短縮されると、障害時に新しいリーダーがより迅速に選択されます。

注記: コントローラーのデフォルト値を変更すると、そのタスク中のシステムパフォーマンスに影響を与える可能性があります。コントローラーの leaseDuration、renewDeadline、または retryPeriod のデフォルト値を変更することで、etcd の負荷を減らすことができます。

必要なアクセス権: クラスター管理者

1.6.5.1. コントローラーフラグの編集

LeaderElection を設定するには、次のデフォルト値を変更します。

-

leader-election-lease-duration: 137 seconds -

renew-deadline: 107 seconds -

retry-period: 26 seconds

multicluster-operators-application、multicluster-operators-channel、multicluster-operators-standalone-subscription、または multicluster-operators-hub-subscription コントローラーを変更するには、次の手順を参照してください。

次のコマンドを実行して、

multiclusterhubを一時停止します。oc annotate mch -n open-cluster-management multiclusterhub mch-pause=true --overwrite=true

oc annotate mch -n open-cluster-management multiclusterhub mch-pause=true --overwrite=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow コントローラー名を

oc editコマンドに追加して、deploymentファイルを編集します。次のコマンド例を参照してください。oc edit deployment -n open-cluster-management multicluster-operators-hub-subscription

oc edit deployment -n open-cluster-management multicluster-operators-hub-subscriptionCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

-commandを検索して、コントローラーコマンドフラグを見つけます。 -

コントローラーのコンテナーセクションから、

-commandフラグを挿入します。たとえば、RetryPeriodを挿入します。 - ファイルを保存します。コントローラーは自動的に再起動してフラグを適用します。

- 変更するコントローラーごとに、この手順を繰り返します。

-

次のコマンドを実行して、

multiclusterhubを再開します。

oc annotate mch -n open-cluster-management multiclusterhub mch-pause=false --overwrite=true

oc annotate mch -n open-cluster-management multiclusterhub mch-pause=false --overwrite=true

-command の編集が成功した場合の次の出力例を参照してください。ここで、retryPeriod フラグは前述のデフォルト時間を 2 倍にして、52 にします。この値は leaderElection の取得を再試行するために割り当てられます。

command: - /usr/local/bin/multicluster-operators-subscription - --sync-interval=60 - --retry-period=52

command:

- /usr/local/bin/multicluster-operators-subscription

- --sync-interval=60

- --retry-period=521.6.6. セキュアな Git 接続用のアプリケーションチャネルおよびサブスクリプションの設定

Git チャネルおよびサブスクリプションは、HTTPS または SSH を使用して指定された Git リポジトリーに接続します。以下のアプリケーションチャネル設定は、セキュアな Git 接続に使用できます。

1.6.6.1. ユーザーおよびアクセストークンを使用したプライベートリポジトリーへの接続

チャネルおよびサブスクリプションを使用して Git サーバーに接続できます。ユーザーおよびアクセストークンを使用してプライベートリポジトリーに接続するには、以下の手順を参照してください。

チャネルと同じ namespace にシークレットを作成します。

userフィールドを Git ユーザー ID に、accessTokenフィールドを Git の個人アクセストークンに設定します。値は base64 でエンコードされる必要があります。user および accessToken が設定された以下の例を参照してください。Copy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットでチャネルを設定します。

secretRefが設定された以下の例を参照してください。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6.6.2. Git サーバーへのセキュアではない HTTPS 接続の設定

開発環境で以下の接続方法を使用し、カスタム署名または自己署名の認証局による SSL 証明書を使用して、プライベートにホストされている Git サーバーに接続できます。ただし、このソリューションは実稼働では推奨されません。

チャネルの仕様で insecureSkipVerify: true を指定します。それ以外の場合は、Git サーバーへの接続が失敗し、以下のようなエラーが表示されます。

x509: certificate is valid for localhost.com, not localhost

x509: certificate is valid for localhost.com, not localhostこの方法のチャネル仕様が追加された以下の例を参照してください。

1.6.6.3. セキュアな HTTPS 接続でのカスタム CA 証明書の使用

この接続方法を使用し、カスタム署名または自己署名の認証局による SSL 証明書を使用して、プライベートにホストされている Git サーバーに安全に接続できます。

Git サーバーの root および中間 CA 証明書を PEM 形式で含む ConfigMap を作成します。ConfigMap はチャネル CR と同じ namespace にある必要があります。フィールド名は

caCertsで、|を使用する必要があります。以下の例で、caCertsには root や中間 CA などの複数の証明書を含めることができる点に留意してください。Copy to Clipboard Copied! Toggle word wrap Toggle overflow この ConfigMap でチャネルを設定します。直前の手順の

git-ca名を使用した以下の例を参照してください。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6.6.4. Git サーバーへの SSH 接続の設定

dataのsshKeyフィールドに SSH 秘密キーを追加するシークレットを作成します。キーがパスフレーズで保護されている場合は、passphraseフィールドにパスワードを指定します。このシークレットは、チャネル CR と同じ namespace にある必要があります。ocコマンドを使用してこのシークレットを作成し、generic のシークレットgit-ssh-key --from-file=sshKey=./.ssh/id_rsaを作成してから、base64 でエンコードされたpassphraseを追加します。以下のサンプルを参照してください。Copy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットでチャネルを設定します。以下のサンプルを参照してください。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow サブスクリプションコントローラーは、提供される Git ホスト名で

ssh-keyscanを行い、SSH 接続での MITM (Man-in-the-middle: 中間者) 攻撃を防ぐためにknown_hostsリストを構築します。これを省略して非セキュアな接続を確立する場合は、チャネル設定でinsecureSkipVerify: trueを使用します。これは、特に実稼働環境でのベストプラクティスではありません。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6.6.5. 証明書および SSH キーの更新

Git チャネル接続設定で CA 証明書、認証情報、または SSH キーなどの更新が必要な場合は、同じ namespace に新規のシークレットおよび ConfigMap を作成し、そのチャネルを更新して新規のシークレットおよび ConfigMap を参照する必要があります。詳細は、セキュアな HTTPS 接続でのカスタム CA 証明書の使用 を参照してください。

1.6.7. namespace リソースを監視するように Helm を設定する

デフォルトでは、サブスクリプションがサブスクライブされた Helm リソースをターゲットクラスターにデプロイするときに、アプリケーションリソースが監視されます。namespace スコープのリソースを監視するように Helm チャネルタイプを設定できます。有効にすると、監視対象の namespace スコープのリソースに対する手動の変更が元に戻されます。

1.6.7.1. 設定

必要なアクセス権限: クラスターの管理者

namespace スコープのリソースを監視するように Helm アプリケーションを設定するには、サブスクリプション定義の watchHelmNamespaceScopedResources フィールドの値を true に設定します。以下のサンプルを参照してください。

1.6.8. アプリケーションをデプロイするマネージドクラスターを OpenShift GitOps オペレーターに登録する

GitOps を設定するには、1 つ以上の Red Hat Advanced Cluster Management for Kubernetes マネージドクラスターのセットを Red Hat OpenShift Container Platform GitOps Operator のインスタンスに登録できます。登録後、アプリケーションをこれらのクラスターにデプロイできます。継続的な GitOps 環境を設定して、開発環境、ステージング、および実稼働環境のクラスター全体でアプリケーションの整合性を自動化します。

1.6.8.1. 前提条件

- Red Hat Advanced Cluster Management for Kubernetes に Red Hat OpenShift GitOps Operator をインストールする必要がある。

- 1 つ以上のマネージドクラスターをインポートする。

1.6.8.2. マネージドクラスターの GitOps への登録

マネージドクラスターを GitOps に登録するには、次の手順を実行します。

マネージドクラスターセットを作成し、マネージドクラスターをこれらのマネージドクラスターセットに追加します。

multicloud-integrations managedclustersetのマネージドクラスターセットの例を参照してください。詳細は、ManagedClusterSet の作成 ドキュメントを参照してください。

-

Red Hat OpenShift GitOps がデプロイされている namespace にバインドするマネージドクラスターセットを作成します。マネージドクラスターを

openshift-gitopsnamespace にバインドする例は、multicloud-integrationsマネージドクラスターセットバインディングの例を参照してください。ManagedClusterSetBindingの作成に関する一般的な情報は、追加リソース セクションの ManagedClusterSetBinding リソースの作成 を参照してください。配置の詳細は、ManagedClusterSets からの ManagedClusters のフィルタリング を参照してください。 マネージドクラスターセットバインディングで使用される namespace で、

Placementカスタムリソースを作成し、OpenShift Container Platform GitOps Operator インスタンスに登録するマネージドクラスターのセットを選択します。multicloud-integration配置例をテンプレートとして使用します。配置情報は、配置での ManagedClusterSets の使用 を参照してください。注記:

- 他の Kubernetes クラスターではなく、Red Hat OpenShift Container Platform GitOps Operator インスタンスに登録されるのは、OpenShift Container Platform クラスターのみです。

-

一部の不安定なネットワークシナリオでは、マネージドクラスターが一時的に使用

unavailableまたはunreachable状態になることがあります。詳細は、Red Hat Advanced Cluster Management および OpenShift GitOps の配置許容範囲の設定 を参照してください。

GitOpsClusterカスタムリソースを作成し、配置決定から OpenShift GitOps の指定されたインスタンスにマネージドクラスターのセットを登録します。これにより、OpenShift GitOps インスタンスは、これらの Red Hat Advanced Cluster Management マネージドクラスターのいずれかにアプリケーションをデプロイできます。multicloud-integrationsGitOps クラスターの例を使用します。注記: 参照される

Placementリソースは、GitOpsClusterリソースと同じ namespace に配置されている必要があります。以下の例を参照してください。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

placementRef.nameの値はall-openshift-clustersで、argoNamespace: openshift-gitopsにインストールされている GitOps インスタンスのターゲットクラスターとして指定されます。argoServer.cluster仕様にはlocal-clusterの値が必要です。

- 変更を保存します。次に、GitOps ワークフローに従って、アプリケーションを管理できます。

1.6.8.3. GitOps トークン

配置および ManagedClusterSetBinding カスタムリソースを使用して GitOps namespace にバインドされているすべてのマネージドクラスターの GitOps Operator と統合すると、ManagedCluster にアクセスするためのトークンが含まれるシークレットがその namespace に作成されます。これは、GitOps コントローラーがリソースをマネージドクラスターと同期するために必要です。ユーザーに GitOps namespace への管理者アクセス権が付与され、アプリケーションのライフサイクル操作を実行すると、ユーザーはこのシークレットへのアクセス権と、マネージドクラスターへの admin レベルのアクセス権が付与されます。

これが望ましくない場合は、ユーザーをこの namespace の範囲の admin ロールにバインドする代わりに、ユーザーをバインドするために作成および使用できるアプリケーションリソースを操作するために必要なアクセス権限がある、より制限の厳しいカスタムロールを使用します。以下の ClusterRole の例を参照してください。

1.6.8.4. 関連情報

- 詳細は Red Hat Advanced Cluster Management および OpenShift GitOps の配置許容範囲の設定 を参照してください。

-

multicloud-integrationsマネージドクラスターセット の例を参照してください。 - ManagedClusterSet の作成 を参照してください。

-

multicloud-integrationの配置 の例を参照してください。 - 配置情報は、Placement overview を参照してください。

-

multicloud-integrationsGitOps クラスター の例を参照してください。 -

multicloud-integrationsマネージドクラスターセットバインディング の例を参照してください。 - 詳細は、ManagedClusterSetBinding リソースの作成 ドキュメントを参照してください。

- 詳細は、GitOps について を参照してください。

1.6.9. Red Hat Advanced Cluster Management および OpenShift GitOps のアプリケーション配置許容の設定

Red Hat Advanced Cluster Management は、アプリケーションを Red Hat OpenShift GitOps にデプロイするマネージドクラスターを登録する方法を提供します。

一部の不安定なネットワークシナリオでは、マネージドクラスターが一時的に使用 Unavailable 状態になることがあります。アプリケーションのデプロイを容易にするために Placement リソースが使用されている場合は、使用できないクラスターを引き続き含めるために、Placement リソースに次の許容範囲を追加します。次の例は、許容範囲を含む Placement リソースを示しています。

1.6.9.1. 関連情報

- OpenShift GitOps オペレーターのマネージドクラスターの設定 を参照してください。

- トピックの最初の Red Hat Advanced Cluster Management および OpenShift GitOps の配置許容範囲の設定 に戻ります。

1.6.10. プッシュアンドプルモデルを使用した Argo CD の導入

Push モデル 使用して、ハブクラスター上の Argo CD サーバーは、マネージドクラスターにアプリケーションリソースをデプロイします。Pull モデル の場合、アプリケーションリソースは manifestWork を使用して Propagation controller によってマネージドクラスターに伝播されます。

テクノロジープレビュー: プルモデルはテクノロジープレビューステータスにあり、このリリースではサポートが制限されています。

どちらのモデルでも、同じ ApplicationSet CRD を使用してアプリケーションをマネージドクラスターにデプロイします。

必要なアクセス権: クラスター管理者

重要: openshift-gitops-ArgoCD-application-controller サービスアカウントがクラスター管理者として割り当てられてい ない 場合、GitOps アプリケーションコントローラーはリソースをデプロイしない可能性があります。アプリケーションのステータスによって、次のようなエラーが送信される場合があります。

cannot create resource "services" in API group "" in the namespace "mortgage",deployments.apps is forbidden: User "system:serviceaccount:openshift-gitops:openshift-gitops-Argo CD-application-controller"

cannot create resource "services" in API group "" in the namespace

"mortgage",deployments.apps is forbidden: User

"system:serviceaccount:openshift-gitops:openshift-gitops-Argo CD-application-controller"クラスター管理者ではなく、この問題を解決する必要がある場合は、次の手順を実行してください。

- Argo CD アプリケーションがデプロイされる各マネージドクラスター上にすべての namespace を作成します。

managed-byラベルを各 namespace に追加します。Argo CD アプリケーションが複数の namespace にデプロイされている場合、各 namespace は Argo CD によって管理される必要があります。managed-byラベルを使用した次の例を参照してください。Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

すべてのアプリケーション宛先 namespace をアプリケーションのリポジトリー内で宣言し、namespace に

managedラベルを含める必要があります。namespace を宣言する方法については、Additional resources を参照してください。

1.6.10.1. Argo CD の Push および Pull モデルのアーキテクチャー

Push および Pull モデルの両方で、ハブクラスター上の Argo CD ApplicationSet コントローラー が調整して、ターゲットのマネージドクラスターごとにアプリケーションリソースを作成します。両方のモデルのアーキテクチャーに関する以下の情報を参照してください。

1.6.10.1.1. Push モデルのアーキテクチャー

- Push モデルの実装には、マネージドクラスターの認証情報を持つハブクラスター上の Argo CD アプリケーションのみが含まれます。ハブクラスター上の Argo CD アプリケーションは、アプリケーションをマネージドクラスターにデプロイできます。

- 重要: リソースアプリケーションを必要とする多数のマネージドクラスターでは、OpenShift Container Platform GitOps コントローラーのメモリーと CPU 使用率に負荷がかかる可能性があることを検討してください。リソース管理を最適化するには、リソースクォータまたは要求の設定 を参照してください。

-

デフォルトでは、

apps.open-cluster-management.io/ocm-managed-clusterおよびapps.open-cluster-management.io/pull-to-ocm-managed-clusterを追加しない限り、アプリケーションのデプロイには Push モデルが使用されます。ApplicationSetのテンプレートセクションに cluster アノテーションを追加します。

1.6.10.1.2. Pull モデルのアーキテクチャー

-

Pull モデルの実装では、OpenShift Cluster Manager の登録、配置、

manifestWorkAPI が適用され、ハブクラスターがハブクラスターとマネージドクラスター間の安全な通信チャネルを使用してリソースをデプロイできるようになります。 -

Pull モデルの場合、Argo CD サーバーが各ターゲットのマネージドクラスターで実行されている必要があります。Argo CD アプリケーションリソースはマネージドクラスター上に複製され、ローカルの Argo CD サーバーによってデプロイされます。マネージドクラスター上の分散 Argo CD アプリケーションは、ハブクラスター上の単一の Argo CD

ApplicationSetリソースを使用して作成されます。 -

マネージドクラスターは、

ocm-managed-clusterアノテーションの値によって決定されます。 -

Pull モデルを正常に実装するには、Argo CD アプリケーションコントローラーは、

ApplicationSetのテンプレートセクションにあるargocd.argoproj.io/skip-reconcileアノテーションを持つプッシュモデルアプリケーションリソースを無視する必要があります。 - Pull モデルの場合、マネージドクラスター上の Argo CD アプリケーションコントローラー が調整してアプリケーションをデプロイします。

- ハブクラスター上の Pull モデル Resource sync controller は、各マネージドクラスター上の OpenShift Cluster Manager 検索 V2 コンポーネントに定期的にクエリーを実行し、各 Argo CD アプリケーションのリソースリストとエラーメッセージを取得します。

-

ハブクラスターの Aggregation controller はリソース同期コントローラーからのデータと、

manifestWorkからのステータス情報を使用して、クラスター全体からMulticlusterApplicationSetReportを作成および更新します。

1.6.10.2. 前提条件

Argo CD Pull モデルを使用するには、以下の前提条件を確認してください。

-

GitOps Operator はハブクラスターに、ターゲットのマネージドクラスターを

openshift-gitopsnamespace にインストールする必要があります。 - 必要なハブクラスター OpenShift Container Platform GitOps operator はバージョン 1.9.0 以降である必要があります。

- 必要なマネージドクラスター OpenShift Container Platform GitOps Operator はハブクラスターと同じバージョンである必要があります。

- マネージドクラスターの Argo CD アプリケーションテンプレートを伝播するには、ApplicationSet コントローラー が必要です。

すべてのマネージドクラスターは、ハブクラスター上の Argo CD サーバー namespace にクラスターシークレットを持っている必要があります。これは、ArgoCD アプリケーションセットコントローラーがマネージドクラスターの Argo CD アプリケーションテンプレートを伝播するために必要です。

クラスターシークレットを作成するには、

placementリソースへの参照が含まれるgitOpsClusterリソースを作成します。placementリソースは、プルモデルをサポートする必要があるすべてのマネージドクラスターを選択します。GitOps クラスターコントローラーが調整すると、Argo CD サーバーの namespace にマネージドクラスターのクラスターシークレットが作成されます。

1.6.10.3. ApplicationSet カスタムリソースの作成

Argo CD ApplicationSet リソースは、マネージドクラスターのリストを取得するために使用されるジェネレーターフィールド内の placement リソースを含むプッシュまたはプルモデルを使用して、マネージドクラスターにアプリケーションをデプロイするために使用されます。

- プルモデルの場合、次の例に示すように、アプリケーションの宛先をデフォルトのローカル Kubernetes サーバーに設定します。アプリケーションは、マネージドクラスター上のアプリケーションコントローラーによってローカルにデプロイされます。

以下の

ApplicationSetYAML の例に示されるように、デフォルトの Push モデルを上書きするために必要なアノテーションを追加します。これは、テンプレートアノテーションで Pull モデルを使用します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6.10.4. MulticlusterApplicationSetReport

-

Pull モデルの場合、

MulticlusterApplicationSetReportはマネージドクラスター全体からアプリケーションステータスを集約します。 - レポートには、リソースのリストと、各マネージドクラスターからのアプリケーションの全体的なステータスが含まれます。

-

Argo CD ApplicationSet リソースごとに個別のレポートリソースが作成されます。レポートは

ApplicationSetと同じ namespace に作成されます。 レポートには次の項目が含まれます。

- Argo CD アプリケーションのリソースのリスト

- 各 Argo CD アプリケーションの全体的な同期およびヘルスステータス

-

全体的なステータスが

out of sync、またはunhealthy各クラスターのエラーメッセージ - 管理対象クラスタのすべての状態を示すサマリーステータス

- Resource sync controller と Aggregation controller は両方とも 10 秒ごとに実行され、レポートを作成します。

次の出力例に示すように、2 つのコントローラーと Propagation コントローラーは、同じ

multicluster-integrationsPod 内の別々のコンテナーで実行されます。NAMESPACE NAME READY STATUS open-cluster-management multicluster-integrations-7c46498d9-fqbq4 3/3 Running

NAMESPACE NAME READY STATUS open-cluster-management multicluster-integrations-7c46498d9-fqbq4 3/3 RunningCopy to Clipboard Copied! Toggle word wrap Toggle overflow

以下は、guestbook アプリケーションの MulticlusterApplicationSetReport YAML ファイルの例です。

Note: リソースがデプロイに失敗した場合、リソースはリソース一覧に含まれません。詳細は、エラーメッセージを参照してください。

1.6.10.5. 関連情報

- OpenShift Container Platform ドキュメントの クラスター設定でアプリケーションをデプロイすることによる OpenShift クラスターの設定 を参照してください。

- OpenShift Container Platform ドキュメントの Argo CD インスタンスのセットアップ を参照してください。

1.6.11. デプロイメントのスケジュール

Helm チャートやその他のリソースを特定の時間にだけデプロイしたり、変更したりする必要がある場合は、このようなリソースにサブスクリプションを定義して、特定の時間にだけ、デプロイメントを開始することができます。あるいは、デプロイメントを制限することもできます。

たとえば、金曜の午後 10 時から午後 11 時の時間帯を、クラスターにパッチや他のアプリケーションの更新を適用する予定メンテナンス枠として定義できます。

ピークの営業時間に想定外のデプロイメントが実行されないように、特定の時間帯にデプロイメントが開始しないように制限またはブロックできます。たとえば、午前 8 時から午後 8 時までデプロイメントを開始しないように、サブスクリプションに時間帯を定義してピーク時を回避できます。

サブスクリプションに期間を定義することで、すべてのアプリケーションおよびクラスターの更新を調整できます。たとえば、午後 6 時 1 分から午後 11 時 59 分までの間に新しいアプリケーションリソースのみをデプロイするようにサブスクリプションを定義し、また別のサブスクリプションに対して、午前 12 時から午前 7 時 59 分までの間に既存のリソースの更新版のみをデプロイするように定義できます。

サブスクリプションに期間を定義すると、サブスクリプションがアクティブな期間が変わります。期間の定義の一部として、期間内のサブスクリプションを active または blocked に定義できます。

サブスクリプションがアクティブな場合にだけ、新規リソースまたは変更リソースのデプロイメントが開始されます。サブスクリプションがアクティブであるか、ブロックされているかに関わらず、サブスクリプションは引き続き、新規リソースや変更リソースがないかどうかを監視します。Active または Blocked の設定は、デプロイメントにだけ影響があります。

新しいリソースまたは変更されたリソースが検出されると、期間の定義をもとに、サブスクリプションの次のアクションが決まります。

-

HelmRepo、ObjectBucket、およびGitタイプのチャネルに対するサブスクリプションの場合: - サブスクリプションが アクティブ な期間にリソースが検出されると、リソースのデプロイメントが開始されます。

- サブスクリプションでのデプロイメントの実行がブロックされている期間外にリソースが検出された場合は、リソースのデプロイ要求がキャッシュされます。次回サブスクリプションがアクティブになると、キャッシュされた要求が適用され、関連のデプロイメントが開始されます。

- 期間が ブロック されると、アプリケーションサブスクリプションで以前にデプロイされたすべてのリソースが残ります。新しい更新は、期間が再度アクティブになるまでブロックされます。

アプリケーションの準期間がブロックされていると、デプロイされたリソースがすべて削除されるとエンドユーザーが誤って判断する場合があります。また、アプリの準期間が再度アクティブになると、元に戻ります。

定義された期間にデプロイメントが開始され、その定義期間終了時を超えてもデプロイメントが実行されている場合は、デプロイメントが完了するまで継続されます。

サブスクリプションの期間を定義するには、必要なフィールドおよび値をサブスクリプションリソース定義 YAML に追加する必要があります。

- 期間の定義では、日付と時間を定義できます。

- 期間タイプも定義できます。このタイプにより、指定の期間中または期間外にデプロイメントを開始できる期間かどうかが決定します。

-

期間タイプが

activeの場合、デプロイメントは、定義した期間中にのみ開始できます。特定のメンテナンス期間にデプロイメントを行う場合に限り、この設定を使用できます。 -

期間タイプが

blockの場合、デプロイメントは、定義した期間中に開始できませんが、それ以外の時間であればいつでも開始できます。この設定は、特定の時間帯のデプロイメントは回避しつつも、必須の重要な更新がある場合に、使用できます。たとえば、セキュリティー関連の更新を午前 10 時から午後 2 時の時間帯以外に実行できるように、期間を定義する場合に、このタイプを使用できます。 - 毎週月曜と水曜に期間を定義するなど、サブスクリプションの期間を複数定義できます。

1.6.12. パッケージの上書きの設定

パッケージが、サブスクリプションに登録されている Helm チャートまたは Kubernetes リソースのサブスクリプション上書き値より優先されるように設定します。

パッケージの上書きを設定するには、path フィールドの値として上書きするように、Kubernetes リソース spec のフィールドを指定します。value フィールドの値として、置き換える値を指定します。

たとえば、サブスクライブしている Helm チャートの Helm リリース spec 内の値フィールドを上書きする必要がある場合は、サブスクリプション定義の path フィールドを spec に設定する必要があります。

packageOverrides:

- packageName: nginx-ingress

packageOverrides:

- path: spec

value: my-override-values

packageOverrides:

- packageName: nginx-ingress

packageOverrides:

- path: spec

value: my-override-values - 1

valueフィールドの内容は、Helm仕様のspecフィールドの値を上書きするのに使用します。-

Helm リリースの場合は、

specフィールドの上書き値が Helm リリースのvalues.yamlファイルにマージされ、既存の値を上書きします。このファイルを使用して、Helm リリースの設定可能な変数を取得します。 Helm リリースのリリース名を上書きする必要がある場合は、定義に

packageOverrideセクションを追加します。以下のフィールドを追加して、Helm リリースのpackageAliasを定義します。-

packageName(Helm チャートを特定) -

packageAlias(リリース名を上書きすることを指定)

デフォルトでは、Helm リリース名が指定されていない場合は、Helm チャート名を使用してリリースを特定します。同じチャートに複数のリリースがサブスクライブされている場合など、競合が発生する可能性があります。リリース名は、namespace 内の全サブスクリプションで一意である必要があります。作成するサブスクリプションのリリース名が一意でない場合は、エラーが発生します。

packageOverrideを定義して、サブスクリプションに異なるリリース名を設定する必要があります。既存のサブスクリプション内の名前を変更する場合は、先にサブスクリプションを削除してから、希望のリリース名でサブスクリプションを作り直す必要があります。-

packageOverrides: - packageName: nginx-ingress packageAlias: my-helm-release-name

packageOverrides: - packageName: nginx-ingress packageAlias: my-helm-release-nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

Helm リリースの場合は、

1.6.13. チャネルサンプルの概要

ファイルの構築に使用できる例および YAML 定義を確認します。チャネル (channel.apps.open-cluster-management.io) では、Red Hat Advanced Cluster Management for Kubernetes アプリケーションを作成して管理するための、向上された継続的インテグレーション/継続的デリバリー機能 (CICD) を提供します。

OpenShift CLI ツールを使用するには、以下の手順を参照します。

- 任意の編集ツールで、アプリケーションの YAML ファイルを作成して保存します。

以下のコマンドを実行してファイルを API サーバーに適用します。

filenameは、使用するファイル名に置き換えます。oc apply -f filename.yaml

oc apply -f filename.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、アプリケーションリソースが作成されていることを確認します。

oc get application.app

oc get application.appCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6.13.1. チャネル YAML の構造

デプロイできるアプリケーションサンプルは、stolostron リポジトリーを参照してください。

以下の YAML 構造は、チャネルの必須フィールドと、一般的な任意のフィールドの一部を示しています。YAML 構造には、必須なフィールドおよび値を追加する必要があります。アプリケーション管理要件によっては、他の任意のフィールドおよび値を追加しないといけない場合があります。独自の YAML コンテンツは、任意のツールや、製品コンソールで作成できます。

1.6.13.2. チャネル YAML 表

| フィールド | 任意または必須 | 詳細 |

|---|---|---|

| apiVersion | 必須 |

この値は |

| kind | 必須 |

この値は |

| metadata.name | 必須 | チャネルの名前。 |

| metadata.namespace | 必須 | チャネルの namespace。各チャネルには Git チャネルを除き、一意の namespace が必要です。 |

| spec.sourceNamespaces | 任意 | チャネルコントローラーが取得してチャネルにプロモートする新規または更新された deployable がないかを監視する namespace を指定してします。 |

| spec.type | 必須 |

チャネルタイプ。サポート対象のタイプは、 |

| spec.pathname |

|

|

| spec.secretRef.name | 任意 |

リポジトリーまたはチャートへのアクセスなど、認証に使用する Kubernetes Secret リソースを指定します。シークレットは、 |

| spec.gates | 任意 |

チャネル内での deployable のプロモート要件を定義します。要件が設定されていない場合は、チャネルの namespace またはソースに追加された deployable がそのチャネルにプロモートされます。 |

| spec.gates.annotations | 任意 | チャネルのアノテーション。チャネル内では deployable に同じアノテーションを追加する必要があります。 |

| metadata.labels | 任意 | チャネルのラベル。 |

| spec.insecureSkipVerify | 任意 |

デフォルト値は |

チャネルの定義構造は、以下の YAML コンテンツのようになります。

1.6.13.3. オブジェクトストレージバケット (ObjectBucket) チャネル

以下のチャネル定義例では、オブジェクトストレージバケットをチャネルとして抽象化します。

1.6.13.4. Helm リポジトリー (HelmRepo) チャネル

以下のチャネル定義例では Helm リポジトリーをチャネルとして抽象化します。

非推奨に関する注記: 2.8 では、チャネルの ConfigMap 参照に insecureSkipVerify: "true" を指定して Helm リポジトリーの SSL 証明書を省略することが非推奨となりました。以下のサンプルで、チャネルで代わりに使用される spec.insecureSkipVerify: true に置き換えられていることを確認してください。

以下のチャネル定義は、Helm リポジトリーチャネルの別の例を示しています。

注記: Helm の場合は、アプリケーショントポロジーが正しく表示されるように、Helm チャートに含まれる Kubernetes リソースにはラベルリリース {{ .Release.Name }}) を含める必要があります。

1.6.13.5. Git (Git) リポジトリーチャネル

以下のチャネル定義例は、Git リポジトリーのチャネルの例を示しています。以下の例では、secretRef は、pathname で指定されている Git リポジトリーにアクセスするときに使用するユーザー ID を参照します。パブリックリポジトリーを使用する場合は、secretRef ラベルと値は必要ありません。

1.6.14. サブスクリプションの例の概要

ファイルの構築に使用できる例および YAML 定義を確認します。チャネルと同様に、サブスクリプション (subscription.apps.open-cluster-management.io) は、アプリケーション管理用に、向上された継続的インテグレーション/継続的デリバリー (CICD) 機能を提供します。

OpenShift CLI ツールを使用するには、以下の手順を参照します。

- 任意の編集ツールで、アプリケーションの YAML ファイルを作成して保存します。

以下のコマンドを実行してファイルを API サーバーに適用します。

filenameは、使用するファイル名に置き換えます。oc apply -f filename.yaml

oc apply -f filename.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、アプリケーションリソースが作成されていることを確認します。

oc get application.app

oc get application.appCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6.14.1. サブスクリプションの YAML 構造

以下の YAML 構造は、サブスクリプションの必須フィールドと、一般的な任意のフィールドの一部を示しています。YAML 構造には、特定の必須フィールドおよび値を追加する必要があります。

アプリケーション管理要件によっては、他の任意のフィールドおよび値を追加しないといけない場合があります。独自の YAML コンテンツは、どのツールでも作成できます。

1.6.14.2. サブスクリプションの YAML 表

| フィールド | 必須またはオプション | 詳細 |

|---|---|---|

| apiVersion | 必須 |

この値は |

| kind | 必須 |

この値は |

| metadata.name | 必須 | サブスクリプションを識別する名前。 |

| metadata.namespace | 必須 | サブスクリプションに使用する namespace リソース。 |

| metadata.labels | 任意 | サブスクリプションのラベル。 |

| spec.channel | 任意 |

サブスクリプションのチャネルを定義する namespace 名 ("Namespace/Name")。 |

| spec.sourceNamespace | 任意 |

deployable を保存するハブクラスター上のソース namespace。このフィールドは namespace チャネルにのみ使用してください。 |

| spec.source | 任意 |

deployable の保存先である Helm リポジトリーのパス名 ("URL")。このフィールドは、Helm リポジトリーチャネルにだけ使用します。 |

| spec.name |

|

チャネル内にあるターゲットの Helm チャートまたは deployable の固有名。任意のフィールドである |

| spec.packageFilter | 任意 | ターゲットの deployable または deployable のサブセットを検索するのに使用するパラメーターを定義します。複数のフィルター条件が定義されている場合、deployable はすべてのフィルター条件を満たす必要があります。 |

| spec.packageFilter.version | 任意 |

deployable のバージョン。バージョンの範囲には |

| spec.packageFilter.annotations | 任意 | deployable のアノテーション。 |

| spec.packageOverrides | 任意 | チャネル内の Helm チャート、deployable、他の Kubernetes リソースなど、サブスクリプションで取得する Kubernetes リソースの上書きを定義するセクションです。 |

| spec.packageOverrides.packageName | 任意ですが、オーバーライドの設定には必須です。 | 上書きされる Kubernetes リソースを特定します。 |

| spec.packageOverrides.packageAlias | 任意 | 上書きされる Kubernetes リソースにエイリアスを指定します。 |

| spec.packageOverrides.packageOverrides | 任意 | Kubernetes リソースの上書きに使用するパラメーターおよび代替値の設定。 |

| spec.placement | 必須 |

deployable を配置する必要のあるサブスクライブクラスター、またはクラスターを定義する配置ルールを特定します。配置設定を使用して、マルチクラスターデプロイメントの値を定義します。非推奨: |

| spec.placement.local | 任意ですが、スタンドアロンクラスターまたは直接管理するクラスターには必須です。 | サブスクリプションをローカルにデプロイする必要があるかどうかを定義します。

サブスクリプションと、指定のチャネルを同期させるには、値を

指定のチャネルからリソースをサブスクライブしないようにするには、この値を

クラスターがスタンドアロンクラスターの場合や、このクラスターを直接管理している場合は、このフィールドを使用します。クラスターがマルチクラスターに含まれており、クラスターを直接管理する必要がない場合は、 |

| spec.placement.clusters | 任意 |

サブスクリプションを配置するクラスターを定義します。 |

| spec.placement.clusters.name | 任意ですが、サブスクライブするクラスターを定義するには必須です。 | サブスクライブするクラスターの名前です。 |

| spec.placement.clusterSelector | 任意 |

サブスクリプションを配置するクラスターを識別するために使用するラベルセレクターを定義します。 |

| spec.placement.placementRef | 任意 |

サブスクリプションに使用する配置ルールを定義します。 |

| spec.placement.placementRef.name | 任意ですが、配置ルールを使用するには必須です。 | サブスクリプションの配置ルールの名前です。 |

| spec.placement.placementRef.kind | 任意ですが、配置ルールを使用するには必須です。 |

この値を |

| spec.overrides | 任意 | クラスター固有の設定など、上書きする必要のあるパラメーターおよび値。 |

| spec.overrides.clusterName | 任意 | パラメーターおよび値を上書するクラスターの名前。 |

| spec.overrides.clusterOverrides | 任意 | 上書きするパラメーターおよび値の設定。 |

| spec.timeWindow | 任意 | サブスクリプションがアクティブな期間、またはブロックされる期間の設定を定義します。 |

| spec.timeWindow.type | 任意ですが、期間の設定には必須 | 設定した期間中に、サブスクリプションがアクティブであるか、ブロックされるかを指定します。サブスクリプションのデプロイメントは、サブスクリプションがアクティブな場合にのみ行われます。 |

| spec.timeWindow.location | 任意ですが、期間の設定には必須 | 設定した期間のタイムゾーン。タイムゾーンはすべて Time Zone (tz) データベース名の形式を使用する必要があります。詳細は、Time Zone Database を参照します。 |

| spec.timeWindow.daysofweek | 任意ですが、期間の設定には必須 |

期間の作成時に時間の範囲を適用する場合は、曜日を指定します。 |

| spec.timeWindow.hours | 任意ですが、期間の設定には必須 | 期間の範囲を定義します。期間ごとに、開始時間と終了時間 (時間単位) を定義する必要があります。サブスクリプションには複数の期間を定義する必要があります。 |

| spec.timeWindow.hours.start | 任意ですが、期間の設定には必須 |

期間の開始を定義するタイムスタンプです。タイムスタンプには、Go プログラミング言語の Kitchen 形式 |

| spec.timeWindow.hours.end | 任意ですが、期間の設定には必須 |

期間の終了を定義するタイムスタンプです。タイムスタンプには、Go プログラミング言語の Kitchen 形式 |

注記:

-

YAML の定義時には、サブスクリプションは

packageFiltersを使用して複数の Helm ダート、deployable、またはその他の Kubernetes リソースを参照できます。ただし、サブスクリプションは、チャート、deployable、その他のリソースの最新バージョンのみをデプロイします。 -

期間の範囲を定義する場合には、開始時間は、終了時間より前に設定する必要があります。サブスクリプションに複数の期間を定義する場合は、期間の範囲を重複させることができません。実際の時間の範囲は、

subscription-controllerのコンテナーの時間をもとにしていますが、作業環境とは異なる時間および場所を設定することができます。 - サブスクリプション仕様では、サブスクリプションの定義の一部として Helm リリースの配置を定義することもできます。サブスクリプションごとに、既存の配置ルールを参照するか、サブスクリプション定義内に直接配置ルールを定義できます。

-

spec.placementセクションに、サブスクリプションの配置先を定義する時には、マルチクラスター環境のclusters、clusterSelector、またはplacementRefの 1 つだけを使用します。 複数の配置設定を追加した場合は、1 つの設定が使用され、他の設定は無視されます。サブスクリプション Operator が使用する設定を決定するために、以下の優先順位で使用されます。

-

placementRef -

clusters -

clusterSelector

-

サブスクリプションは、以下の YAML コンテンツのようになります。

1.6.14.3. サブスクリプションファイルの例

デプロイできるアプリケーションサンプルは、stolostron リポジトリーを参照してください。

1.6.14.4. セカンダリーチャネルの例

ミラーリングされたチャネル (アプリケーションソースリポジトリー) がある場合は、サブスクリプション YAML に secondaryChannel を指定できます。アプリケーションサブスクリプションがプライマリーチャネルを使用してリポジトリーサーバーへの接続に失敗した場合、セカンダリーチャネルを使用してリポジトリーサーバーに接続します。セカンダリーチャネルに保存されるアプリケーションマニフェストがプライマリーチャネルと同期されていることを確認します。secondaryChannel の以下のサブスクリプション YAML のサンプルを参照してください。

1.6.14.4.1. サブスクリプションの時間枠の例

以下のサブスクリプションの例には、設定された時間枠が複数含まれています。指定の時間枠は、毎週月曜、水曜、金曜の午前 10 時 20 分から午前 10 時半の間と、毎週月曜、水曜、金曜の午後 12 時 40 分から午後 1 時 40 分の間です。1 週間でこの 6 つの時間枠内にだけ、サブスクリプションがアクティブで、デプロイメントを開始できます。

timewindow には、タイプの目的に応じて、active または blocked を入力します。

1.6.14.4.2. 上書きを使用したサブスクリプションの例

以下の例には、パッケージの上書きが含まれており、Helm チャートの Helm リリースに異なるリリース名を定義します。パッケージの上書き設定は、nginx-ingress Helm リリースの別のリリース名として、my-nginx-ingress-releaseName の名前を設定するために使用します。

1.6.14.4.3. Helm リポジトリーのサブスクリプションの例

以下のサブスクリプションは、バージョンが 1.36.x の最新の nginx Helm リリースを自動的にプルします。ソースの Helm リポジトリーで新規バージョンが利用できる場合、Helm リリースの deployable は my-development-cluster-1 クラスターに配置されます。

spec.packageOverrides セクションでは、Helm リリースの上書き値の任意パラメーターを指定します。上書き値は、Helm リリースの values.yaml ファイルにマージされ、このファイルを使用して Helm リリースの設定可能な値を取得します。

1.6.14.4.4. Git リポジトリーのサブスクリプションの例

1.6.14.4.4.1. Git リポジトリーの特定ブランチおよびディレクトリーのサブスクライブ

このサブスクリプションの例では、apps.open-cluster-management.io/git-path のアノテーションは、チャネルに指定されている Git リポジトリーの sample_app_1/dir1 ディレクトリーにある Helm チャートおよび Kubernetes リソースのすべてをサブスクリプションがサブスクライブするように指定します。サブスクリプションは、デフォルトで master ブランチにサブスクライブします。このサブスクリプションの例では、apps.open-cluster-management.io/git-branch: branch1 のアノテーションを指定して、リポジトリーの branch1 ブランチをサブスクライブしています。

注意: Helm チャートにサブスクライブする Git チャネルサブスクリプションを使用している場合には、リソーストポロジービューには追加の Helmrelease リソースが表示される可能性があります。このリソースは内部アプリケーションの管理リソースであるため、無視しても問題はありません。

1.6.14.4.4.2. .kubernetesignore ファイルの追加

Git リポジトリーの root ディレクトリー、またはサブスクリプションのアノテーションで指定した apps.open-cluster-management.io/git-path ディレクトリーに .kubernetesignore ファイルを追加できます。

この .kubernetesignore ファイルを使用して、サブスクリプションが、そのリポジトリーから Kubernetes リソースまたは Helm チャートをデプロイするときに無視するファイルまたはサブディレクトリー、もしくはその両方を指定することができます。

また、.kubernetesignore ファイルを使用して、詳細に絞り込み、選択した Kubernetes リソースだけを適用することもできます。.kubernetesignore ファイルのパターン形式は、.gitignore ファイルと同じです。

apps.open-cluster-management.io/git-path アノテーションが定義されていないと、サブスクリプションは、リポジトリーの root ディレクトリーで .kubernetesignore ファイルを検索します。apps.open-cluster-management.io/git-path フィールドが定義されていると、サブスクリプションは apps.open-cluster-management.io/git-path ディレクトリーで .kubernetesignore ファイルを検索します。サブスクリプションは、他のディレクトリーでは .kubernetesignore ファイルの検索は行いません。

1.6.14.4.4.3. Kustomize の適用

サブスクライブする Git のフォルダーに kustomization.yaml ファイルまたは kustomization.yml ファイルがある場合は、kustomize が適用されます。spec.packageOverrides を使用して、サブスクリプションのデプロイメント時に kustomization を上書きできます。

kustomization.yaml ファイルを上書きするには、packageOverrides に packageName: kustomization が必要です。上書きは、新規エントリーを追加するか、既存のエントリーを更新します。既存のエントリーは削除されません。

1.6.14.4.4.4. Git WebHook の有効化

デフォルトでは、Git チャネルのサブスクリプションは、チャネルで指定されている Git リポジトリーを 1 分ごとにクローンし、コミット ID が変更されたら、変更が適用されます。または、リポジトリーのプッシュまたはプルの Webhook イベント通知を Git リポジトリーが送信する場合にのみ、変更を適用するようにサブスクリプションを設定できます。

Git リポジトリーで Webhook を設定するには、ターゲット Webhook ペイロード URL と、シークレット (任意) が必要です。

1.6.14.4.4.4.1. ペイロード URL

ハブクラスターでルート (Ingress) を作成し、サブスクリプション Operator の Webhook イベントリスナーサービスを公開します。

oc create route passthrough --service=multicluster-operators-subscription -n open-cluster-management

oc create route passthrough --service=multicluster-operators-subscription -n open-cluster-management

次に、oc get route multicluster-operators-subscription -n open-cluster-management コマンドを使用して、外部からアクセスできるホスト名を見つけます。

webhook のペイロード URL は https://<externally-reachable hostname>/webhook です。

1.6.14.4.4.4.2. Webhook シークレット

Webhook シークレットは任意です。チャネル namespace に Kubernetes Secret を作成します。シークレットには data.secret を含める必要があります。

以下の例を参照してください。

data.secret の値は、使用する base-64 でエンコードされた WebHook シークレットに置き換えます。

ベストプラクティス: Git リポジトリーごとに一意のシークレットを使用してください。

1.6.14.4.4.4.3. Git リポジトリーでの Webhook の設定

ペイロード URL および Webhook シークレットを使用して Git リポジトリーで Webhook を設定します。

1.6.14.4.4.4.4. チャネルでの Webhook イベント通知の有効化

サブスクリプションチャネルにアノテーションを追加します。以下の例を参照してください。

oc annotate channel.apps.open-cluster-management.io <channel name> apps.open-cluster-management.io/webhook-enabled="true"

oc annotate channel.apps.open-cluster-management.io <channel name> apps.open-cluster-management.io/webhook-enabled="true"

WebHook の設定にシークレットを使用した場合は、これにも、チャネルにアノテーションを付けます。<the_secret_name> は Webhook シークレットを含む kubernetes シークレット名に置き換えます。

oc annotate channel.apps.open-cluster-management.io <channel name> apps.open-cluster-management.io/webhook-secret="<the_secret_name>"

oc annotate channel.apps.open-cluster-management.io <channel name> apps.open-cluster-management.io/webhook-secret="<the_secret_name>"サブスクリプションには Webhook 固有の設定は必要ありません。

1.6.15. Placement ルールのサンプルの概要 (非推奨)

非推奨: PlacementRules は非推奨になりました。代わりに Placement を使用してください。

配置ルール (placementrule.apps.open-cluster-management.io) は、deployable をデプロイ可能なターゲットクラスターを定義します。配置ルールを使用すると、deployable のマルチクラスターでのデプロイメントが容易になります。

OpenShift CLI ツールを使用するには、以下の手順を参照します。

- 任意の編集ツールで、アプリケーションの YAML ファイルを作成して保存します。

以下のコマンドを実行してファイルを API サーバーに適用します。

filenameは、使用するファイル名に置き換えます。oc apply -f filename.yaml

oc apply -f filename.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、アプリケーションリソースが作成されていることを確認します。

oc get application.app

oc get application.appCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6.15.1. 配置ルールの YAML 構造

以下の YAML 構造は、配置ルールの必須フィールドと、一般的な任意のフィールドの一部を示しています。YAML 構造には、必須なフィールドおよび値を追加する必要があります。アプリケーション管理要件によっては、他の任意のフィールドおよび値を追加しないといけない場合があります。独自の YAML コンテンツは、任意のツールや、製品コンソールで作成できます。

1.6.15.2. 配置ルールの YAML 値の表

| フィールド | 必須またはオプション | 詳細 |

|---|---|---|

| apiVersion | 必須 |

この値は |

| kind | 必須 |

この値は |

| metadata.name | 必須 | 配置ルールを識別する名前。 |

| metadata.namespace | 必須 | 配置ルールに使用する namespace リソース。 |

| metadata.resourceVersion | 任意 | 配置ルールのリソースのバージョン。 |

| metadata.labels | 任意 | 配置ルールのラベル。 |

| spec.clusterSelector | 任意 | ターゲットクラスターを特定するラベル。 |

| spec.clusterSelector.matchLabels | 任意 | ターゲットクラスターに含める必要があるラベル。 |

| spec.clusterSelector.matchExpressions | 任意 | ターゲットクラスターに含める必要があるラベル。 |

| status.decisions | 任意 | deployable を配置するターゲットクラスターを定義します。 |

| status.decisions.clusterName | 任意 | ターゲットクラスターの名前。 |

| status.decisions.clusterNamespace | 任意 | ターゲットクラスターの namespace。 |

| spec.clusterReplicas | 任意 | 作成するレプリカの数。 |

| spec.clusterConditions | 任意 | クラスターの条件を定義します。 |

| spec.ResourceHint | 任意 | 以前のフィールドで指定したラベルと値に複数のクラスターが一致した場合は、リソース固有の基準を指定してクラスターを選択することができます。たとえば、利用可能な CPU コアの最大数で、クラスターを選択できます。 |

| spec.ResourceHint.type | 任意 |

この値を |

| spec.ResourceHint.order | 任意 |

この値は、昇順の場合は |

| spec.Policies | 任意 | 配置ルールのポリシーフィルター。 |

1.6.15.3. 配置ルールファイルの例

デプロイできるアプリケーションサンプルは、stolostron リポジトリーを参照してください。

既存の配置ルールに、以下のフィールドを追加して、配置ルールのステータスを指定することができます。このステータスのセクションは、ルールの YAML 構造の spec セクションの後に追加できます。

status:

decisions:

clusterName:

clusterNamespace:

status:

decisions:

clusterName:

clusterNamespace:| フィールド | 詳細 |

|---|---|

| status | 配置ルールのステータス情報。 |

| status.decisions | deployable を配置するターゲットクラスターを定義します。 |

| status.decisions.clusterName | ターゲットクラスターの名前。 |

| status.decisions.clusterNamespace | ターゲットクラスターの namespace。 |

- 例 1

- 例 2

1.6.16. アプリケーションの例

ファイルの構築に使用できる例および YAML 定義を確認します。Red Hat Advanced Cluster Management for Kubernetes のアプリケーション (Application.app.k8s.io) は、アプリケーションコンポーネントの表示に使用します。

OpenShift CLI ツールを使用するには、以下の手順を参照します。

- 任意の編集ツールで、アプリケーションの YAML ファイルを作成して保存します。

以下のコマンドを実行してファイルを API サーバーに適用します。

filenameは、使用するファイル名に置き換えます。oc apply -f filename.yaml

oc apply -f filename.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、アプリケーションリソースが作成されていることを確認します。

oc get application.app

oc get application.appCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6.16.1. アプリケーションの YAML 構造

アプリケーション定義 YAML コンテンツを作成して、アプリケーションリソースを作成または更新するには、YAML 構造に、必須のフィールドおよび値を追加する必要があります。アプリケーション要件やアプリケーション管理の要件によっては、他の任意のフィールドや値を追加しないといけない場合があります。

以下の YAML 構造は、アプリケーションの必須フィールドと、一般的な任意のフィールドの一部を示しています。

1.6.16.2. アプリケーションの YAML 表

| フィールド | 値 | 詳細 |

|---|---|---|

| apiVersion |

| 必須 |

| kind |

| 必須 |

| metadata | ||

|

| 必須 | |

|

| ||

| spec | ||

| selector.matchLabels |

このアプリケーションを関連付けるサブスクリプションにある Kubernetes ラベルと値の | 必須 |

これらのアプリケーションの定義仕様は、Kubernetes Special Interest Group (SIG) が提供するアプリケーションメタデータ記述子のカスタムリソース定義が基になっています。テーブルに表示される値のみが必要です。

この定義を使用すると、独自のアプリケーションの YAML コンテンツ作成に役立ちます。この定義の詳細は、Kubernetes SIG Application CRD community specification を参照してください。

1.6.16.3. アプリケーションファイルの例

デプロイできるアプリケーションサンプルは、stolostron リポジトリーを参照してください。

アプリケーションの定義構造は、以下の YAML コンテンツの例のようになります。