AMQ Streams on RHEL の使用

AMQ Streams 1.8 on Red Hat Enterprise Linux 向け

概要

多様性を受け入れるオープンソースの強化

Red Hat では、コード、ドキュメント、Web プロパティーにおける配慮に欠ける用語の置き換えに取り組んでいます。まずは、マスター (master)、スレーブ (slave)、ブラックリスト (blacklist)、ホワイトリスト (whitelist) の 4 つの用語の置き換えから始めます。これは大規模な取り組みであるため、これらの変更は今後の複数のリリースで段階的に実施されます。詳細は、Red Hat CTO である Chris Wright のメッセージをご覧ください。

第1章 AMQ Streams の概要

Red Hat AMQ Streams は、Apache ZooKeeper および Apache Kafka プロジェクトに基づく、拡張性の高い、分散型の高パフォーマンスのデータストリーミングプラットフォームです。

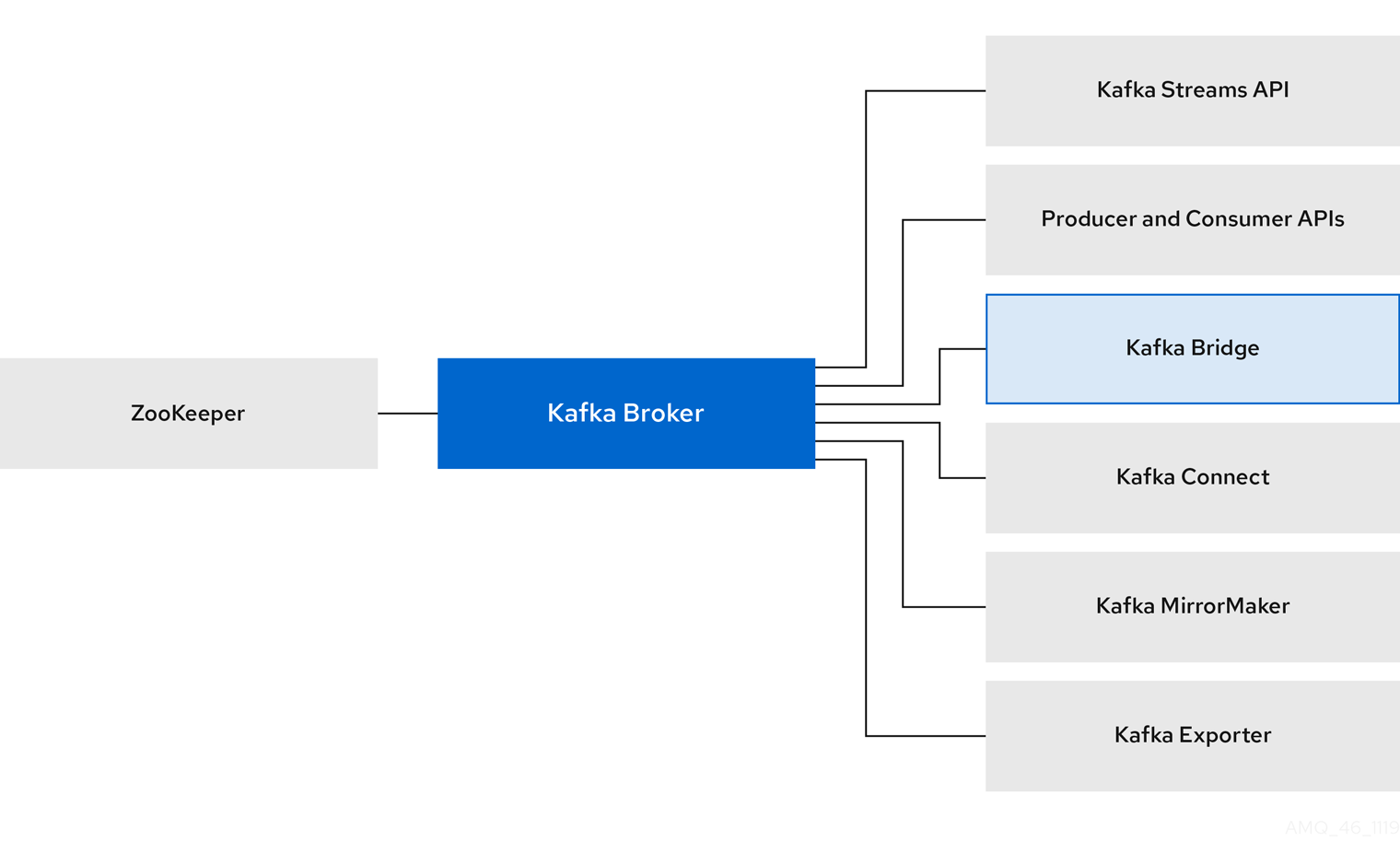

主なコンポーネントは以下で構成されます。

- Kafka Broker

生成側クライアントから消費側クライアントにレコードを配信するメッセージングブローカー。

Apache ZooKeeper は Kafka のコア依存関係で、非常に信頼性の高い分散型の連携のためのクラスター調整サービスを提供します。

- Kafka Streams API

- ストリームプロセッサー アプリケーションを記述するための API

- プロデューサーおよびコンシューマー API

- Kafka ブローカーとの間でメッセージを生成および消費するための Java ベースの API。

- Kafka Bridge

- AMQ Streams Kafka Bridge では、HTTP ベースのクライアントと Kafka クラスターとの対話を可能にする RESTful インターフェースが提供されます。

- Kafka Connect

- コネクター プラグインを使用して Kafka ブローカーと他のシステムの間でデータをストリーミングするツールキット。

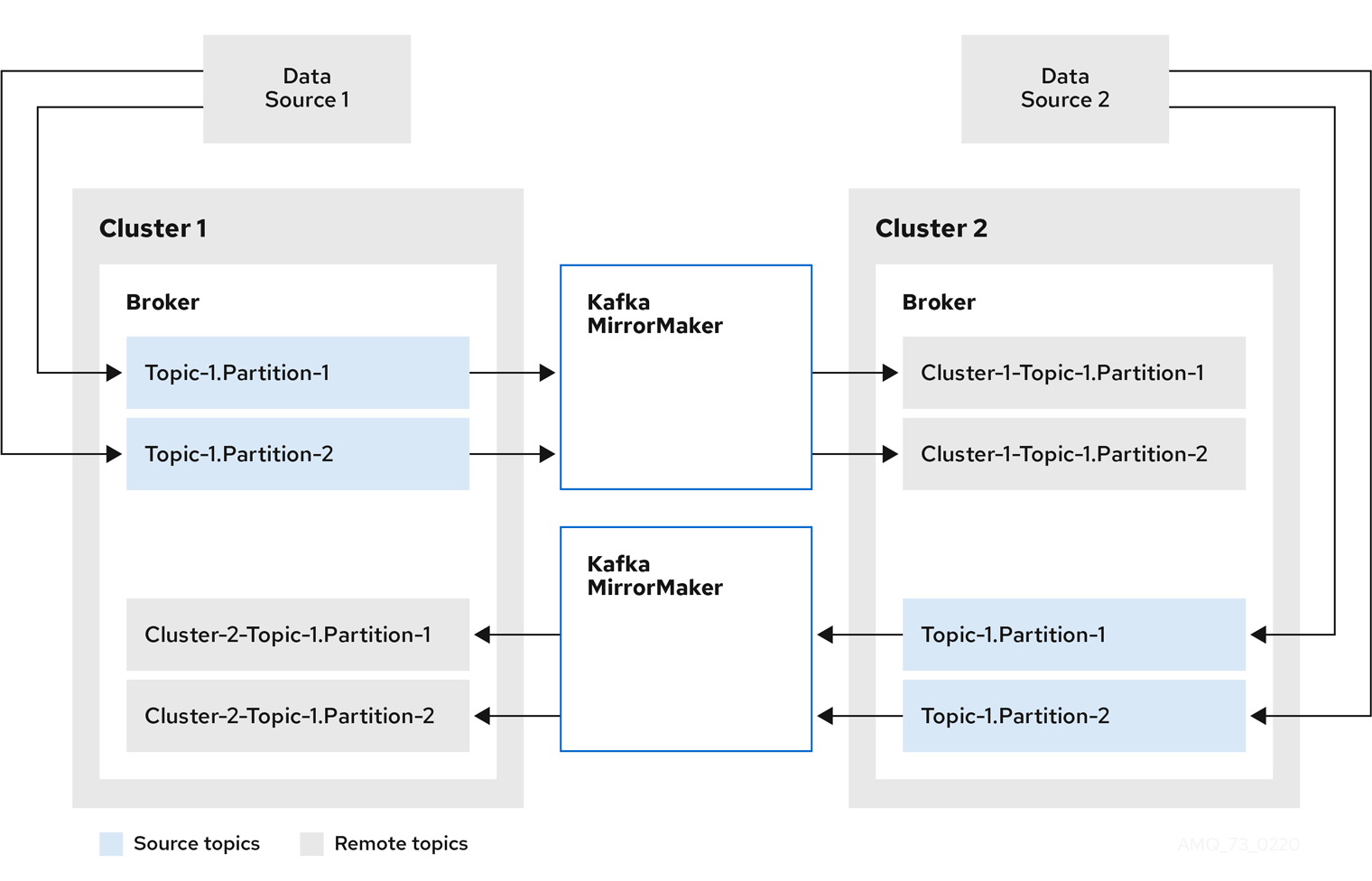

- Kafka MirrorMaker

- データセンター内または異なるデータセンターにある 2 つの Kafka クラスター間でデータをレプリケートします。

- Kafka Exporter

- 監視用に Kafka メトリクスデータの抽出に使用されるエクスポーター。

Kafka ブローカーのクラスターは、これらの全コンポーネントを接続するハブです。ブローカーは、設定データの保存やクラスターの連携に Apache ZooKeeper を使用します。Apache Kafka の実行前に、Apache ZooKeeper クラスターを用意する必要があります。

図1.1 AMQ Streams のアーキテクチャー

1.1. Kafka の機能

Kafka の基盤のデータストリーム処理機能とコンポーネントアーキテクチャーによって以下が提供されます。

- スループットが非常に高く、レイテンシーが低い状態でデータを共有するマイクロサービスおよびその他のアプリケーション。

- メッセージの順序の保証。

- アプリケーションの状態を再構築するためにデータストレージからメッセージを巻き戻し/再生。

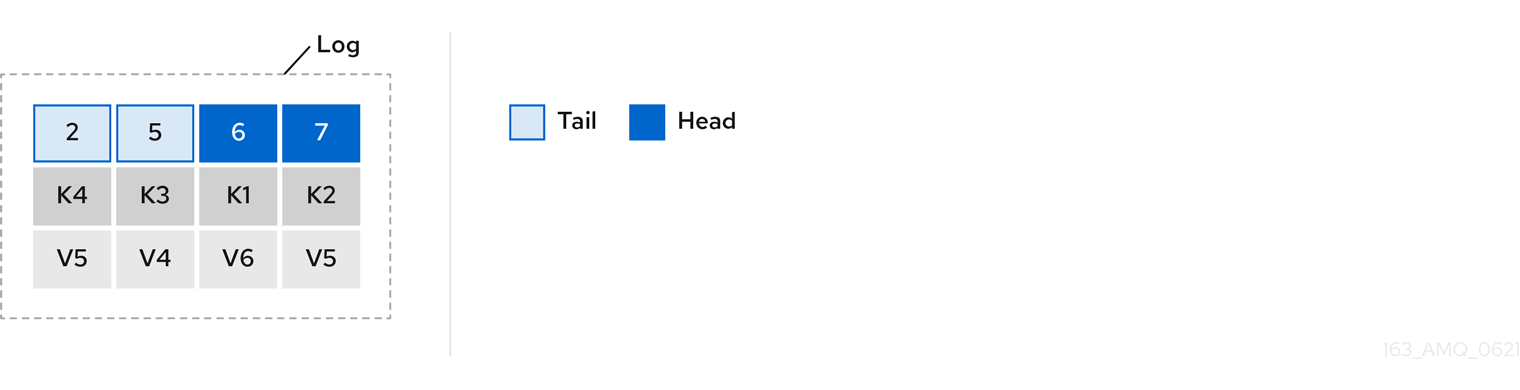

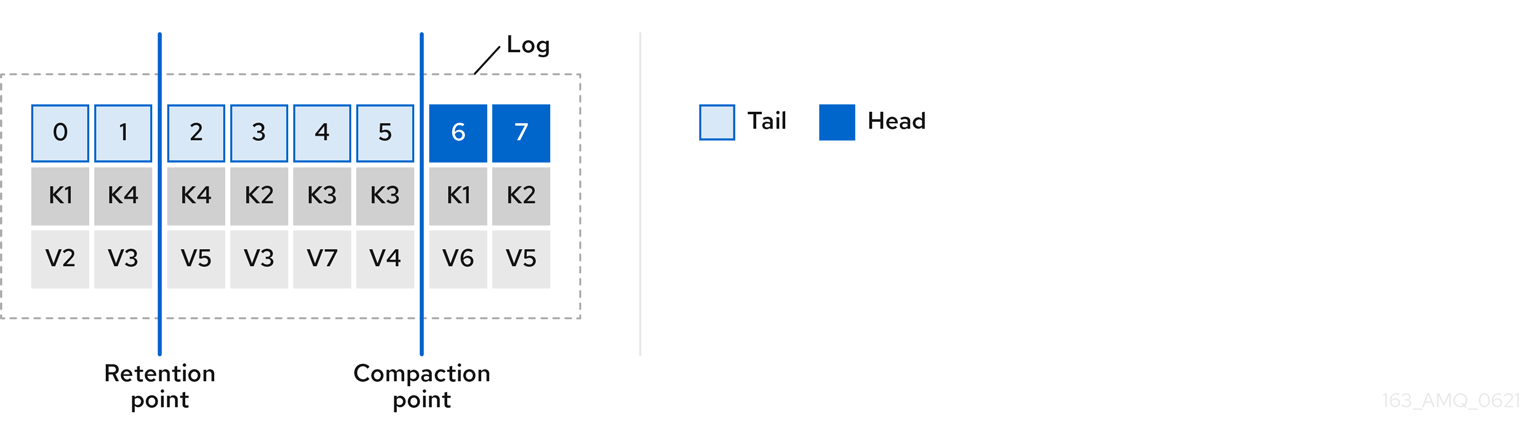

- キーバリューログの使用時に古いレコードを削除するメッセージコンパクション。

- クラスター設定での水平スケーラビリティー。

- 耐障害性を制御するデータのレプリケーション。

- 即座にアクセスするために大容量のデータを保持。

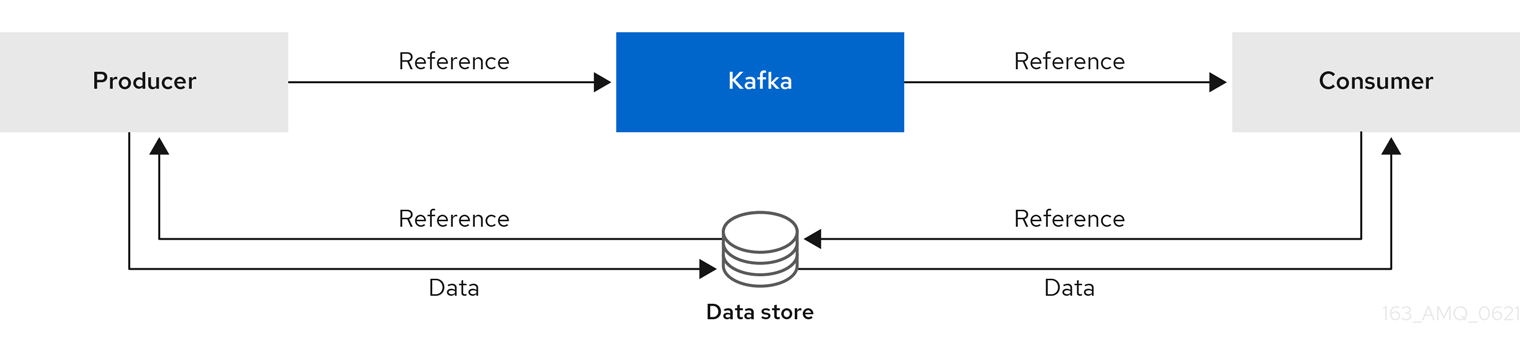

1.2. Kafka のユースケース

Kafka の機能は、以下に適しています。

- イベント駆動型のアーキテクチャー。

- アプリケーションの状態変更をイベントのログとしてキャプチャーするイベントソーシング。

- メッセージのブローカー。

- Web サイトアクティビティーの追跡。

- メトリクスによるオペレーションの監視。

- ログの収集および集計。

- 分散システムのログのコミット。

- アプリケーションがリアルタイムでデータに対応できるようにするストリーム処理。

1.3. サポートされる構成

AMQ Streams をサポートされる構成で実行するには、以下の JVM バージョンの 1 つと、サポートされるオペレーティングシステムの 1 つで実行する必要があります。

| Java 仮想マシン | バージョン |

|---|---|

| OpenJDK | 1.8、11 |

| OracleJDK | 1.8、11 |

| IBM JDK | 1.8 |

| オペレーティングシステム | アーキテクチャー | バージョン |

|---|---|---|

| Red Hat Enterprise Linux (RHEL) | x86_64 | 7.x、8.x |

1.4. 本書の表記慣例

置き換え可能なテキスト

本書では、置き換え可能なテキストは、monospace フォントのイタリック体、大文字、およびハイフンで記載されています。

たとえば、以下のコードでは、BOOTSTRAP-ADDRESS および TOPIC-NAME を実際のアドレスおよびトピック名に置き換えます。

bin/kafka-console-consumer.sh --bootstrap-server BOOTSTRAP-ADDRESS --topic TOPIC-NAME --from-beginning

bin/kafka-console-consumer.sh --bootstrap-server BOOTSTRAP-ADDRESS --topic TOPIC-NAME --from-beginning第2章 スタートガイド

2.1. AMQ Streams の配布

AMQ Streams は単一の ZIP ファイルとして配布されます。この ZIP ファイルには AMQ Streams のコンポーネントが含まれています。

- Apache ZooKeeper

- Apache Kafka

- Apache Kafka Connect

- Apache Kafka MirrorMaker

- Kafka Bridge

- Kafka Exporter

2.2. AMQ Streams アーカイブのダウンロード

AMQ Streams のアーカイブディストリビューションは、Red Hat の Web サイトからダウンロードできます。以下の手順に従うと、ディストリビューションのコピーをダウンロードできます。

手順

- カスタマーポータル から最新バージョンの Red Hat AMQ Streams アーカイブをダウンロードします。

2.3. AMQ Streams のインストール

以下の手順に従って、最新バージョンの AMQ Streams on Red Hat Enterprise Linux をインストールします。

既存のクラスターを AMQ Streams 1.8 にアップグレードする手順は、「AMQ Streams および Kafka のアップグレード」を参照してください。

前提条件

- インストールアーカイブ のダウンロード。

- 「サポートされる構成」の確認。

手順

新しい

kafkaユーザーおよびグループを追加します。sudo groupadd kafka sudo useradd -g kafka kafka sudo passwd kafka

sudo groupadd kafka sudo useradd -g kafka kafka sudo passwd kafkaCopy to Clipboard Copied! Toggle word wrap Toggle overflow ディレクトリー

/opt/kafkaを作成します。sudo mkdir /opt/kafka

sudo mkdir /opt/kafkaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 一時ディレクトリーを作成し、AMQ Streams ZIP ファイルの内容を展開します。

mkdir /tmp/kafka unzip amq-streams_y.y-x.x.x.zip -d /tmp/kafka

mkdir /tmp/kafka unzip amq-streams_y.y-x.x.x.zip -d /tmp/kafkaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 展開した内容を

/opt/kafkaディレクトリーに移動して、一時ディレクトリーを削除します。sudo mv /tmp/kafka/kafka_y.y-x.x.x/* /opt/kafka/ rm -r /tmp/kafka

sudo mv /tmp/kafka/kafka_y.y-x.x.x/* /opt/kafka/ rm -r /tmp/kafkaCopy to Clipboard Copied! Toggle word wrap Toggle overflow /opt/kafkaディレクトリーの所有権をkafkaユーザーに変更します。sudo chown -R kafka:kafka /opt/kafka

sudo chown -R kafka:kafka /opt/kafkaCopy to Clipboard Copied! Toggle word wrap Toggle overflow ZooKeeper データを格納するディレクトリー

/var/lib/zookeeperを作成し、その所有権をkafkaユーザーに設定します。sudo mkdir /var/lib/zookeeper sudo chown -R kafka:kafka /var/lib/zookeeper

sudo mkdir /var/lib/zookeeper sudo chown -R kafka:kafka /var/lib/zookeeperCopy to Clipboard Copied! Toggle word wrap Toggle overflow Kafka データを格納するディレクトリー

/var/lib/kafkaを作成し、その所有権をkafkaユーザーに設定します。sudo mkdir /var/lib/kafka sudo chown -R kafka:kafka /var/lib/kafka

sudo mkdir /var/lib/kafka sudo chown -R kafka:kafka /var/lib/kafkaCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4. データストレージに関する留意事項

効率的なデータストレージインフラストラクチャーは、AMQ Streams のパフォーマンスを最適化するために不可欠です。

AMQ Streams にはブロックストレージが必要であり、Amazon Elastic Block Store (EBS) などのクラウドベースのブロックストレージソリューションと適切に機能します。ファイルストレージの使用は推奨されていません。

可能な場合はローカルストレージを選択します。ローカルストレージが利用できない場合には、Fibre Channel または iSCSI などのプロトコルでアクセスする Storage Area Network (SAN) を使用できます。

2.4.1. Apache Kafka および ZooKeeper ストレージのサポート

Apache Kafka と ZooKeeper には別々のディスクを使用します。

Kafka は、複数ディスクまたはボリュームのデータストレージ設定である JBOD (Just a Bunch of Disks) ストレージをサポートします。JBOD は、Kafka ブローカーのデータストレージを増やします。また、パフォーマンスを向上することもできます。

ソリッドステートドライブ (SSD) は必須ではありませんが、複数のトピックに対してデータが非同期的に送受信される大規模なクラスターで Kafka のパフォーマンスを向上させることができます。SSD は、高速で低レイテンシーのデータアクセスが必要な ZooKeeper で特に有効です。

Kafka と ZooKeeper の両方にデータレプリケーションが組み込まれているため、複製されたストレージのプロビジョニングは必要ありません。

2.4.2. ファイルシステム

XFS ファイルシステムを使用するようにストレージシステムを設定することが推奨されます。AMQ Streams は ext4 ファイルシステムとも互換性がありますが、最適化するには追加の設定が必要になることがあります。

その他のリソース

- XFS の詳細は、「The XFS File System」を参照してください。

2.5. 単一ノードの AMQ Streams クラスターの実行

この手順では、単一の Apache ZooKeeper ノードと単一の Apache Kafka ノード (両方が同じホスト上で実行されている) で構成される、基本的な AMQ Streams クラスターを実行する方法を説明します。デフォルトの設定ファイルは、ZooKeeper および Kafka に使用されます。

単一ノードの AMQ Streams クラスターは、信頼性と高可用性を提供せず、開発の目的にのみ適しています。

前提条件

- AMQ Streams がホストにインストールされている。

クラスターの実行

ZooKeeper 設定ファイル

/opt/kafka/config/zookeeper.propertiesを編集します。dataDirオプションを/var/lib/zookeeper/に設定します。dataDir=/var/lib/zookeeper/

dataDir=/var/lib/zookeeper/Copy to Clipboard Copied! Toggle word wrap Toggle overflow Kafka 設定ファイル

/opt/kafka/config/server.propertiesを編集します。log.dirsオプションを/var/lib/kafka/に設定します。log.dirs=/var/lib/kafka/

log.dirs=/var/lib/kafka/Copy to Clipboard Copied! Toggle word wrap Toggle overflow kafkaユーザーに切り替えます。su - kafka

su - kafkaCopy to Clipboard Copied! Toggle word wrap Toggle overflow ZooKeeper を起動します。

/opt/kafka/bin/zookeeper-server-start.sh -daemon /opt/kafka/config/zookeeper.properties

/opt/kafka/bin/zookeeper-server-start.sh -daemon /opt/kafka/config/zookeeper.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow ZooKeeper が実行していることを確認します。

jcmd | grep zookeeper

jcmd | grep zookeeperCopy to Clipboard Copied! Toggle word wrap Toggle overflow 戻り値:

number org.apache.zookeeper.server.quorum.QuorumPeerMain /opt/kafka/config/zookeeper.properties

number org.apache.zookeeper.server.quorum.QuorumPeerMain /opt/kafka/config/zookeeper.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow Kafka を起動します。

/opt/kafka/bin/kafka-server-start.sh -daemon /opt/kafka/config/server.properties

/opt/kafka/bin/kafka-server-start.sh -daemon /opt/kafka/config/server.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow Kafka が稼働していることを確認します。

jcmd | grep kafka

jcmd | grep kafkaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 戻り値:

number kafka.Kafka /opt/kafka/config/server.properties

number kafka.Kafka /opt/kafka/config/server.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

その他のリソース

- AMQ Streams のインストールに関する詳細は、「AMQ Streams のインストール」を参照してください。

- AMQ Streams の設定に関する詳細は、「AMQ Streams の設定」を参照してください。

2.6. クラスターの使用

この手順では、Kafka コンソールプロデューサーおよびコンシューマークライアントを起動し、それらを使用して複数のメッセージを送受信する方法を説明します。

新しいトピックは、ステップ 1 で自動的に作成されます。トピックの自動作成 は、auto.create.topics.enable 設定プロパティーを使用して制御されます (デフォルトでは true に設定されます)。または、クラスターを使用する前にトピックを設定および作成することができます。詳細は「トピック」を参照してください。

手順

Kafka コンソールプロデューサーを起動し、メッセージを新しいトピックに送信するように設定します。

/opt/kafka/bin/kafka-console-producer.sh --broker-list <bootstrap-address> --topic <topic-name>

/opt/kafka/bin/kafka-console-producer.sh --broker-list <bootstrap-address> --topic <topic-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

/opt/kafka/bin/kafka-console-producer.sh --broker-list localhost:9092 --topic my-topic

/opt/kafka/bin/kafka-console-producer.sh --broker-list localhost:9092 --topic my-topicCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンソールに複数のメッセージを入力します。Enter を押して、各メッセージを新しいトピックに送信します。

>message 1 >message 2 >message 3 >message 4

>message 1 >message 2 >message 3 >message 4Copy to Clipboard Copied! Toggle word wrap Toggle overflow Kafka が新しいトピックを自動的に作成すると、トピックが存在しないという警告が表示される場合があります。

WARN Error while fetching metadata with correlation id 39 : {4-3-16-topic1=LEADER_NOT_AVAILABLE} (org.apache.kafka.clients.NetworkClient)WARN Error while fetching metadata with correlation id 39 : {4-3-16-topic1=LEADER_NOT_AVAILABLE} (org.apache.kafka.clients.NetworkClient)Copy to Clipboard Copied! Toggle word wrap Toggle overflow この警告は、さらにメッセージを送信すると再度表示されなくなります。

新しいターミナルウィンドウで、Kafka コンソールコンシューマーを起動して、新しいトピックの最初からメッセージを読み取るように設定します。

/opt/kafka/bin/kafka-console-consumer.sh --bootstrap-server <bootstrap-address> --topic <topic-name> --from-beginning

/opt/kafka/bin/kafka-console-consumer.sh --bootstrap-server <bootstrap-address> --topic <topic-name> --from-beginningCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

/opt/kafka/bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic my-topic --from-beginning

/opt/kafka/bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic my-topic --from-beginningCopy to Clipboard Copied! Toggle word wrap Toggle overflow 受信メッセージがコンシューマーコンソールに表示されます。

- プロデューサーコンソールに切り替え、追加のメッセージを送信します。それらがコンシューマーコンソールに表示されていることを確認します。

- Ctrl+C を押して Kafka コンソールプロデューサーを停止し、続いてコンシューマーを停止します。

2.7. AMQ Streams サービスの停止

スクリプトを実行して、Kafka および ZooKeeper サービスを停止できます。Kafka および ZooKeeper サービスへのすべての接続が終了します。

前提条件

- AMQ Streams がホストにインストールされている。

- ZooKeeper および Kafka が稼働している。

手順

Kafka ブローカーを停止します。

su - kafka /opt/kafka/bin/kafka-server-stop.sh

su - kafka /opt/kafka/bin/kafka-server-stop.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow Kafka ブローカーが停止していることを確認します。

jcmd | grep kafka

jcmd | grep kafkaCopy to Clipboard Copied! Toggle word wrap Toggle overflow ZooKeeper を停止します。

su - kafka /opt/kafka/bin/zookeeper-server-stop.sh

su - kafka /opt/kafka/bin/zookeeper-server-stop.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.8. AMQ Streams の設定

前提条件

- AMQ Streams がホストにダウンロードされ、インストールされている。

手順

テキストエディターで ZooKeeper および Kafka ブローカー設定ファイルを開きます。設定ファイルは以下にあります。

- ZooKeeper

-

/opt/kafka/config/zookeeper.properties - Kafka

-

/opt/kafka/config/server.properties

設定オプションを編集します。設定ファイルは Java プロパティー形式です。すべての設定オプションは、次の形式で別々の行に指定する必要があります。

<option> = <value>

<option> = <value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow #または!で始まる行はコメントとして処理され、AMQ Streams コンポーネントによって無視されます。This is a comment

# This is a commentCopy to Clipboard Copied! Toggle word wrap Toggle overflow 改行/キャリッジリターンの直前で

\を使用して、値を複数の行に分割することができます。sasl.jaas.config=org.apache.kafka.common.security.plain.PlainLoginModule required \ username="bob" \ password="bobs-password";sasl.jaas.config=org.apache.kafka.common.security.plain.PlainLoginModule required \ username="bob" \ password="bobs-password";Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を保存します。

- ZooKeeper または Kafka ブローカーを再起動します。

- クラスターのすべてのノードでこの手順を繰り返します。

第3章 ZooKeeper の設定

Kafka は ZooKeeper を使用して設定データを保存し、クラスター内の連携を行います。レプリケートされた ZooKeeper インスタンスのクラスターを実行することが強く推奨されます。

3.1. 基本設定

最も重要な ZooKeeper 設定オプションは以下のとおりです。

tickTime- ZooKeeper の基本時間単位 (ミリ秒単位)。これはハートビートとセッションタイムアウトに使用されます。たとえば、最小セッションタイムアウトは 2 ティックになります。

dataDir-

ZooKeeper がトランザクションログとインメモリーデータベースのスナップショットを保存するディレクトリー。これは、インストール時に作成された

/var/lib/zookeeper/ディレクトリーに設定する必要があります。 clientPort-

クライアントが接続できるポート番号。デフォルトは

2181です。

config/zookeeper.properties という名前の ZooKeeper 設定ファイルのサンプルは、AMQ Streams のインストールディレクトリーに置かれます。ZooKeeper でレイテンシーを最小限に抑えるために、別のディスクデバイスに dataDir ディレクトリーを配置することが推奨されます。

ZooKeeper 設定ファイルは /opt/kafka/config/zookeeper.properties に配置する必要があります。設定ファイルの基本的な例は以下で確認できます。設定ファイルは kafka ユーザーが読み取りできる必要があります。

tickTime=2000 dataDir=/var/lib/zookeeper/ clientPort=2181

tickTime=2000

dataDir=/var/lib/zookeeper/

clientPort=21813.2. ZooKeeper クラスターの設定

ほとんどの実稼働環境では、レプリケートされた ZooKeeper インスタンスのクラスターをデプロイすることが推奨されます。安定した高可用性 ZooKeeper クラスターの実行は、信頼できる ZooKeeper サービスにとって重要です。ZooKeeper クラスターは、アンサンブル とも呼ばれます。

ZooKeeper クラスターは通常、奇数のノードで構成されます。ZooKeeper では、クラスター内のほとんどのノードが稼働している必要があります。以下に例を示します。

- 3 つのノードで構成されるクラスターでは、少なくとも 2 つのノードが稼働している必要があります。これは、1 つのノードが停止していることを許容できることを意味します。

- 5 つのノードで構成されるクラスターでは、最低でも 3 つのノードが利用可能である必要があります。これは、2 つのノードが停止していることを許容できることを意味します。

- 7 つのノードで構成されるクラスターでは、最低でも 4 つのノードが利用可能である必要があります。これは、3 つのノードが停止していることを許容できることを意味します。

ZooKeeper クラスターにより多くのノードがあると、クラスター全体の回復性および信頼性が向上します。

ZooKeeper は、偶数のノードを持つクラスターで実行できます。ただし、追加のノードは、クラスターの回復性を向上させません。4 つのノードで構成されるクラスターでは、少なくとも 3 つのノードが利用可能である必要があり、停止しているノードは 1 つしか許容できません。そのため、3 つのノードでしか構成されないクラスターとまったく同じ回復性しか持ちません。

理想的には、異なる ZooKeeper ノードを異なるデータセンターまたはネットワークセグメントに置く必要があります。ZooKeeper ノードの数を増やすと、クラスター同期に費やされたワークロードが増えます。ほとんどの Kafka のユースケースでは、3、5、または 7 つのノードで構成される ZooKeeper クラスターで十分です。

3 つのノードで構成される ZooKeeper クラスターでは、利用できないノードは 1 つしか許容できません。つまり、クラスターノードがクラッシュした時に別のノードでメンテナンスを実施中だった場合、ZooKeeper クラスターが利用できなくなることを意味します。

レプリケートされた ZooKeeper の構成は、スタンドアロン設定でサポートされるすべての設定オプションをサポートします。クラスタリング設定にさらにオプションが追加されます。

initLimit-

フォロワーがクラスターリーダーに接続して同期できるようにする時間。時間はティック数として指定されます (詳細は

timeTickオプション を参照してください)。 syncLimit-

フォロワーがリーダーの背後にいられる時間。時間はティック数として指定されます (詳細は

timeTickオプション を参照してください)。 reconfigEnabled- 動的再設定 を有効または無効にします。サーバーを ZooKeeper クラスターに追加または削除するには、有効にする必要があります。

standaloneEnabled- ZooKeeper が 1 つだけのサーバーで実行されるスタンドアロンモードを有効または無効にします。

上記のオプションの他に、すべての設定ファイルに ZooKeeper クラスターのメンバーである必要があるサーバーの一覧が含まれている必要があります。サーバーレコードは server.id=hostname:port1:port2 の形式で指定する必要があります。ここで、

id- ZooKeeper クラスターノードの ID。

hostname- ノードが接続をリッスンするホスト名または IP アドレス。

port1- イントラクラスター通信に使用されるポート番号。

port2- リーダーの選択に使用するポート番号。

以下は、3 つのノードで構成される ZooKeeper クラスターの設定ファイルの例です。

ZooKeeper 3.5.7 では、使用する前に、許可リストに 4 文字の コマンドを追加する必要があります。詳細は、ZooKeeper のドキュメント を参照してください。

myid ファイル

ZooKeeper クラスターの各ノードには、一意の ID を割り当てる必要があります。各ノードの ID は myid ファイルで設定し、/var/lib/zookeeper/ などの dataDir フォルダーに保存する必要があります。myid ファイルには、テキストとして ID が記述された単一行のみが含まれている必要があります。ID には、1 から 255 までの任意の整数を指定することができます。このファイルは、各クラスターノードに手動で作成する必要があります。このファイルを使用すると、各 ZooKeeper インスタンスは設定ファイルの対応する server. 行の設定を使用して、そのリスナーを設定します。また、他の server. 行すべてを使用して、他のクラスターメンバーを特定します。

上記の例では、3 つのノードがあるので、各ノードは値がそれぞれ 1、2、および 3 の異なる myid を持ちます。

3.3. マルチノードの ZooKeeper クラスターの実行

この手順では、ZooKeeper をマルチノードクラスターとして設定、実行する方法を説明します。

ZooKeeper 3.5.7 では、使用する前に、許可リストに 4 文字の コマンドを追加する必要があります。詳細は、ZooKeeper のドキュメント を参照してください。

前提条件

- AMQ Streams が、ZooKeeper クラスターノードとして使用されるすべてのホストにインストールされている。

クラスターの実行

/var/lib/zookeeper/にmyidファイルを作成します。最初の ZooKeeper ノードに ID1を、2 番目の ZooKeeper ノードに2を、それぞれ入力します。su - kafka echo "<NodeID>" > /var/lib/zookeeper/myid

su - kafka echo "<NodeID>" > /var/lib/zookeeper/myidCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

su - kafka echo "1" > /var/lib/zookeeper/myid

su - kafka echo "1" > /var/lib/zookeeper/myidCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のように ZooKeeper の

/opt/kafka/config/zookeeper.properties設定ファイルを編集します。-

dataDirオプションを/var/lib/zookeeper/に設定します。 -

initLimitおよびsyncLimitオプションを設定します。 -

reconfigEnabledおよびstandaloneEnabledオプションを設定します。 すべての ZooKeeper ノードの一覧を追加します。この一覧には、現在のノードも含まれている必要があります。

5 つのメンバーを持つ ZooKeeper クラスターのノードの設定例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

デフォルトの設定ファイルで ZooKeeper を起動します。

su - kafka /opt/kafka/bin/zookeeper-server-start.sh -daemon /opt/kafka/config/zookeeper.properties

su - kafka /opt/kafka/bin/zookeeper-server-start.sh -daemon /opt/kafka/config/zookeeper.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow ZooKeeper が稼働していることを確認します。

jcmd | grep zookeeper

jcmd | grep zookeeperCopy to Clipboard Copied! Toggle word wrap Toggle overflow - クラスターのすべてのノードでこの手順を繰り返します。

クラスターのすべてのノードが稼働したら、

ncatユーティリティーを使用してstatコマンドを各ノードに送信して、すべてのノードがクラスターのメンバーであることを確認します。ncat stat を使用してノードのステータスを確認します。

echo stat | ncat localhost 2181

echo stat | ncat localhost 2181Copy to Clipboard Copied! Toggle word wrap Toggle overflow この出力に、ノードが

leaderまたはfollowerのいずれかである情報が表示されるはずです。ncatコマンドの出力例Copy to Clipboard Copied! Toggle word wrap Toggle overflow

その他のリソース

- AMQ Streams のインストールに関する詳細は、「AMQ Streams のインストール」を参照してください。

- AMQ Streams の設定に関する詳細は、「AMQ Streams の設定」を参照してください。

3.4. 認証

デフォルトでは、ZooKeeper はどのような認証も使用せず、匿名の接続を許可します。ただし、Simple Authentication and Security Layer (SASL) を使用して認証を設定するのに使用できる Java Authentication and Authorization Service (JAAS) をサポートします。ZooKeeper は、ローカルに保存されたクレデンシャルで DIGEST-MD5 SASL メカニズムを使用する認証をサポートします。

3.4.1. SASL を使用した認証

JAAS は個別の設定ファイルを使用して設定されます。JAAS 設定ファイルを ZooKeeper 設定と同じディレクトリー (/opt/kafka/config/) に置くことが推奨されます。推奨されるファイル名は zookeeper-jaas.conf です。マルチノードの ZooKeeper クラスターを使用する場合は、JAAS 設定ファイルをすべてのクラスターノードで作成する必要があります。

JAAS はコンテキストを使用して設定されます。サーバーとクライアントなど、個別の要素は常に個別の コンテキスト で設定されます。コンテキストは 設定 オプションで、以下の形式となっています。

ContextName {

param1

param2;

};

ContextName {

param1

param2;

};SASL 認証は、サーバー間通信 (ZooKeeper インスタンス間の通信) とクライアント間の通信 (Kafka と ZooKeeper 間の通信) 用に、個別に設定されます。サーバー間の認証は、マルチノードの ZooKeeper クラスターにのみ関連します。

サーバー間の認証

サーバー間の認証では、JAAS 設定ファイルには 2 つの部分が含まれています。

- サーバー設定

- クライアント設定

DIGEST-MD5 SASL メカニズムを使用する場合、認証サーバーの設定に QuorumServer コンテキストが使用されます。暗号化されていない形式のパスワードと共に、接続が許可されるすべてのユーザー名を含める必要があります。2 つ目のコンテキスト QuorumLearner は、ZooKeeper に組み込まれるクライアント用に設定する必要があります。これにも、暗号化されていない形式のパスワードが含まれます。DIGEST-MD5 メカニズムの JAAS 設定ファイルの例は、以下を参照してください。

JAAS 設定ファイルの他に、以下のオプションを指定して、通常の ZooKeeper 設定ファイルでサーバー間の認証を有効にする必要があります。

KAFKA_OPTS 環境変数を使用して、JAAS 設定ファイルを Java プロパティーとして ZooKeeper サーバーに渡します。

su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/zookeeper-jaas.conf"; /opt/kafka/bin/zookeeper-server-start.sh -daemon /opt/kafka/config/zookeeper.properties

su - kafka

export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/zookeeper-jaas.conf"; /opt/kafka/bin/zookeeper-server-start.sh -daemon /opt/kafka/config/zookeeper.propertiesサーバー間の認証の詳細は、ZooKeeper wiki を参照してください。

クライアント/サーバー間の認証

クライアント/サーバー間の認証は、サーバー間の認証と同じ JAAS ファイルで設定されます。ただし、サーバー間の認証とは異なり、サーバー設定のみが含まれます。設定のクライアント部分は、クライアントで実行する必要があります。認証を使用して ZooKeeper に接続するように Kafka ブローカーを設定する方法については、Kafka のインストール セクションを参照してください。

JAAS 設定ファイルにサーバーコンテキストを追加して、クライアント/サーバー間の認証を設定します。DIGEST-MD5 メカニズム用に、すべてのユーザー名とパスワードが設定されます。

JAAS コンテキストの設定後、以下の行を追加して ZooKeeper 設定ファイルでクライアント/サーバー間の認証を有効にします。

requireClientAuthScheme=sasl authProvider.1=org.apache.zookeeper.server.auth.SASLAuthenticationProvider authProvider.2=org.apache.zookeeper.server.auth.SASLAuthenticationProvider authProvider.3=org.apache.zookeeper.server.auth.SASLAuthenticationProvider

requireClientAuthScheme=sasl

authProvider.1=org.apache.zookeeper.server.auth.SASLAuthenticationProvider

authProvider.2=org.apache.zookeeper.server.auth.SASLAuthenticationProvider

authProvider.3=org.apache.zookeeper.server.auth.SASLAuthenticationProvider

ZooKeeper クラスターの一部であるすべてのサーバーに authProvider.<ID> プロパティーを追加する必要があります。

KAFKA_OPTS 環境変数を使用して、JAAS 設定ファイルを Java プロパティーとして ZooKeeper サーバーに渡します。

su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/zookeeper-jaas.conf"; /opt/kafka/bin/zookeeper-server-start.sh -daemon /opt/kafka/config/zookeeper.properties

su - kafka

export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/zookeeper-jaas.conf"; /opt/kafka/bin/zookeeper-server-start.sh -daemon /opt/kafka/config/zookeeper.propertiesKafka ブローカーでの ZooKeeper 認証の設定に関する詳細は、「ZooKeeper の認証」を参照してください。

3.4.2. DIGEST-MD5 を使用したサーバー間の認証の有効化

この手順では、ZooKeeper クラスターのノード間で SASL DIGEST-MD5 メカニズムを使用した認証を有効にする方法を説明します。

前提条件

- AMQ Streams がホストにインストールされている。

- ZooKeeper クラスターがマルチノードで 設定されている。

SASL DIGEST-MD5 認証の有効化

すべての ZooKeeper ノードで、

/opt/kafka/config/zookeeper-jaas.confJAAS 設定ファイルを作成または編集し、以下のコンテキストを追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow ユーザー名とパスワードは、両方の JAAS コンテキストで同一である必要があります。以下に例を示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow すべての ZooKeeper ノードで、

/opt/kafka/config/zookeeper.propertiesZooKeeper 設定ファイルを編集し、以下のオプションを設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow すべての ZooKeeper ノードを 1 つずつ再起動します。JAAS 設定を ZooKeeper に渡すには、

KAFKA_OPTS環境変数を使用します。su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/zookeeper-jaas.conf"; /opt/kafka/bin/zookeeper-server-start.sh -daemon /opt/kafka/config/zookeeper.properties

su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/zookeeper-jaas.conf"; /opt/kafka/bin/zookeeper-server-start.sh -daemon /opt/kafka/config/zookeeper.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

その他のリソース

- AMQ Streams のインストールに関する詳細は、「AMQ Streams のインストール」を参照してください。

- AMQ Streams の設定に関する詳細は、「AMQ Streams の設定」を参照してください。

- ZooKeeper クラスターの実行に関する詳細は、「マルチノードの ZooKeeper クラスターの実行」を参照してください。

3.4.3. DIGEST-MD5 を使用したクライアント/サーバー間の認証の有効化

この手順では、ZooKeeper クライアントと ZooKeeper との間で SASL DIGEST-MD5 メカニズムを使用した認証を有効にする方法を説明します。

前提条件

- AMQ Streams がホストにインストールされている。

- ZooKeeper クラスターが 設定済みで実行されている。

SASL DIGEST-MD5 認証の有効化

すべての ZooKeeper ノードで、

/opt/kafka/config/zookeeper-jaas.confJAAS 設定ファイルを作成または編集し、以下のコンテキストを追加します。Server { org.apache.zookeeper.server.auth.DigestLoginModule required user_super="<SuperUserPassword>" user<Username1>_="<Password1>" user<USername2>_="<Password2>"; };Server { org.apache.zookeeper.server.auth.DigestLoginModule required user_super="<SuperUserPassword>" user<Username1>_="<Password1>" user<USername2>_="<Password2>"; };Copy to Clipboard Copied! Toggle word wrap Toggle overflow superには、管理者権限が自動的に付与されます。このファイルには複数のユーザーを含めることができますが、Kafka ブローカーが必要とする追加ユーザーは 1 人だけです。Kafka ユーザーに推奨される名前はkafkaです。以下の例は、クライアント/サーバー間の認証の

Serverコンテキストを示しています。Server { org.apache.zookeeper.server.auth.DigestLoginModule required user_super="123456" user_kafka="123456"; };Server { org.apache.zookeeper.server.auth.DigestLoginModule required user_super="123456" user_kafka="123456"; };Copy to Clipboard Copied! Toggle word wrap Toggle overflow すべての ZooKeeper ノードで、

/opt/kafka/config/zookeeper.propertiesZooKeeper 設定ファイルを編集し、以下のオプションを設定します。requireClientAuthScheme=sasl authProvider.<IdOfBroker1>=org.apache.zookeeper.server.auth.SASLAuthenticationProvider authProvider.<IdOfBroker2>=org.apache.zookeeper.server.auth.SASLAuthenticationProvider authProvider.<IdOfBroker3>=org.apache.zookeeper.server.auth.SASLAuthenticationProvider

requireClientAuthScheme=sasl authProvider.<IdOfBroker1>=org.apache.zookeeper.server.auth.SASLAuthenticationProvider authProvider.<IdOfBroker2>=org.apache.zookeeper.server.auth.SASLAuthenticationProvider authProvider.<IdOfBroker3>=org.apache.zookeeper.server.auth.SASLAuthenticationProviderCopy to Clipboard Copied! Toggle word wrap Toggle overflow authProvider.<ID>プロパティーは、ZooKeeper クラスターの一部であるすべてのノードに追加する必要があります。3 ノードで構成される ZooKeeper クラスターの設定例は以下のようになります。requireClientAuthScheme=sasl authProvider.1=org.apache.zookeeper.server.auth.SASLAuthenticationProvider authProvider.2=org.apache.zookeeper.server.auth.SASLAuthenticationProvider authProvider.3=org.apache.zookeeper.server.auth.SASLAuthenticationProvider

requireClientAuthScheme=sasl authProvider.1=org.apache.zookeeper.server.auth.SASLAuthenticationProvider authProvider.2=org.apache.zookeeper.server.auth.SASLAuthenticationProvider authProvider.3=org.apache.zookeeper.server.auth.SASLAuthenticationProviderCopy to Clipboard Copied! Toggle word wrap Toggle overflow すべての ZooKeeper ノードを 1 つずつ再起動します。JAAS 設定を ZooKeeper に渡すには、

KAFKA_OPTS環境変数を使用します。su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/zookeeper-jaas.conf"; /opt/kafka/bin/zookeeper-server-start.sh -daemon /opt/kafka/config/zookeeper.properties

su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/zookeeper-jaas.conf"; /opt/kafka/bin/zookeeper-server-start.sh -daemon /opt/kafka/config/zookeeper.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

その他のリソース

- AMQ Streams のインストールに関する詳細は、「AMQ Streams のインストール」を参照してください。

- AMQ Streams の設定に関する詳細は、「AMQ Streams の設定」を参照してください。

- ZooKeeper クラスターの実行に関する詳細は、「マルチノードの ZooKeeper クラスターの実行」を参照してください。

3.5. 承認

ZooKeeper は、そこに格納されているデータを保護するためにアクセス制御リスト (ACL) をサポートします。Kafka ブローカーは、他の ZooKeeper ユーザーが変更できないように、作成するすべての ZooKeeper レコードに ACL 権限を自動的に設定できます。

Kafka ブローカーでの ZooKeeper ACL の有効化に関する詳細は、「ZooKeeper の承認」を参照してください。

3.6. TLS

ZooKeeper は、暗号化または認証用に TLS をサポートします。

3.7. その他の設定オプション

ユースケースに基づいて、以下の追加の ZooKeeper 設定オプションを設定できます。

maxClientCnxns- ZooKeeper クラスターの単一メンバーへの同時クライアント接続の最大数。

autopurge.snapRetainCount-

保持される ZooKeeper のインメモリーデータベースのスナップショット数。デフォルト値は

3です。 autopurge.purgeInterval-

スナップショットをパージする間隔 (時間単位)。デフォルト値は

0で、このオプションは無効になります。

利用可能なすべての設定オプションは、ZooKeeper のドキュメント を参照してください。

3.8. ロギング

ZooKeeper は、ロギングインフラストラクチャーとして log4j を使用しています。ロギング設定は、デフォルトでは /opt/kafka/config/ ディレクトリーまたはクラスパスのいずれかに配置される log4j.properties 設定ファイルから読み取られます。設定ファイルの場所と名前は、Java プロパティー log4j.configuration を使用して変更できます。これは、KAFKA_LOG4J_OPTS 環境変数を使用して ZooKeeper に渡すことができます。

su - kafka export KAFKA_LOG4J_OPTS="-Dlog4j.configuration=file:/my/path/to/log4j.properties"; /opt/kafka/bin/zookeeper-server-start.sh -daemon /opt/kafka/config/zookeeper.properties

su - kafka

export KAFKA_LOG4J_OPTS="-Dlog4j.configuration=file:/my/path/to/log4j.properties"; /opt/kafka/bin/zookeeper-server-start.sh -daemon /opt/kafka/config/zookeeper.propertiesLog4j の設定に関する詳細は、Log4j のドキュメント を参照してください。

第4章 Kafka の設定

Kafka はプロパティーファイルを使用して静的設定を保存します。推奨される設定ファイルの場所は /opt/kafka/config/server.properties です。設定ファイルは kafka ユーザーが読み取りできる必要があります。

AMQ Streams には、製品のさまざまな基本的な機能と高度な機能を記述する設定ファイルの例が含まれています。AMQ Streams インストールディレクトリーの config/server.properties を参照してください。

本章では、最も重要な設定オプションを説明します。サポートされる Kafka ブローカー設定オプションの完全リストは、「付録A ブローカー設定パラメーター」を参照してください。

4.1. ZooKeeper

クラスターの連携 (たとえば、どのノードをどのパーティションのリーダーにするかを決定する場合など) に加えて、Kafka ブローカーには、設定の一部を格納するために ZooKeeper が必要になります。ZooKeeper クラスターの接続の詳細は、設定ファイルに保存されます。zookeeper.connect フィールドには、zookeeper クラスターのメンバーのホスト名およびポートのコンマ区切りリストが含まれます。

以下に例を示します。

zookeeper.connect=zoo1.my-domain.com:2181,zoo2.my-domain.com:2181,zoo3.my-domain.com:2181

zookeeper.connect=zoo1.my-domain.com:2181,zoo2.my-domain.com:2181,zoo3.my-domain.com:2181

Kafka はこれらのアドレスを使用して ZooKeeper クラスターに接続します。この設定により、すべての Kafka znodes が ZooKeeper データベースのルートに直接作成されます。そのため、このような ZooKeeper クラスターは単一の Kafka クラスターに対してのみ使用できます。複数の Kafka クラスターが単一の ZooKeeper クラスターを使用するように設定するには、Kafka 設定ファイルの ZooKeeper 接続文字列の最後にベース (プレフィックス) パスを指定します。

zookeeper.connect=zoo1.my-domain.com:2181,zoo2.my-domain.com:2181,zoo3.my-domain.com:2181/my-cluster-1

zookeeper.connect=zoo1.my-domain.com:2181,zoo2.my-domain.com:2181,zoo3.my-domain.com:2181/my-cluster-14.2. リスナー

リスナーは、Kafka ブローカーへの接続に使用されます。各 Kafka ブローカーは、複数のリスナーを使用するように設定できます。各リスナーには異なる設定が必要で、これにより別のポートまたはネットワークインターフェースでリッスンすることができます。

リスナーを設定するには、設定ファイル (/opt/kafka/config/server.properties) の listeners プロパティーを編集します。listeners プロパティーにリスナーをコンマ区切りのリストとして追加します。各プロパティーを以下のように設定します。

<listenerName>://<hostname>:<port>

<listenerName>://<hostname>:<port>

<hostname> が空の場合、Kafka は java.net.InetAddress.getCanonicalHostName() クラスをホスト名として使用します。

複数リスナーの設定例

listeners=internal-1://:9092,internal-2://:9093,replication://:9094

listeners=internal-1://:9092,internal-2://:9093,replication://:9094

Kafka クライアントが Kafka クラスターに接続する場合、最初にクラスターノードの 1 つである ブートストラップサーバー に接続します。ブートストラップサーバーはクライアントにクラスター内のすべてのブローカーの一覧を提供し、クライアントは各ブローカーに個別に接続します。ブローカーのリストは、設定された listeners に基づいています。

アドバタイズされたリスナー

任意で、advertised.listeners プロパティーを使用して、listeners プロパティーに指定されたものとは異なるリスナーアドレスのセットをクライアントに提供できます。これは、プロキシーなどの追加のネットワークインフラストラクチャーがクライアントとブローカー間にある場合、または IP アドレスではなく外部 DNS 名が使用されている場合に便利です。

advertised.listeners プロパティーは、listeners プロパティーと同じようにフォーマットされます。

アドバタイズされたリスナーの設定例

listeners=internal-1://:9092,internal-2://:9093 advertised.listeners=internal-1://my-broker-1.my-domain.com:1234,internal-2://my-broker-1.my-domain.com:1235

listeners=internal-1://:9092,internal-2://:9093

advertised.listeners=internal-1://my-broker-1.my-domain.com:1234,internal-2://my-broker-1.my-domain.com:1235

アドバタイズされたリスナーの名前は、listeners プロパティーに記載されているものと一致する必要があります。

ブローカー間のリスナー

ブローカー間のリスナーは、Kafka ブローカー間の通信に使用されます。ブローカー間の通信は以下に必要です。

- 異なるブローカー間のワークロードの調整

- 異なるブローカーに格納されているパーティション間でのメッセージのレプリケーション

- パーティションリーダーシップの変更など、コントローラーからの管理タスクの処理

ブローカー間のリスナーは、希望のポートに割り当てることができます。複数のリスナーが設定されている場合、inter.broker.listener.name プロパティーでブローカー間リスナーの名前を定義できます。

ここでは、ブローカー間リスナーの名前は REPLICATION です。

listeners=REPLICATION://0.0.0.0:9091 inter.broker.listener.name=REPLICATION

listeners=REPLICATION://0.0.0.0:9091

inter.broker.listener.name=REPLICATIONコントロールプレーンリスナー

デフォルトでは、コントローラーと他のブローカー間の通信には、ブローカー間のリスナー が使用されます。コントローラーは、パーティションリーダーの変更などの管理タスクを調整します。

コントローラー接続用に、専用の コントロールプレーンリスナー を有効にすることができます。コントロールプレーンリスナーは、希望のポートに割り当てることができます。

コントロールプレーンリスナーを有効にするには、リスナー名で control.plane.listener.name プロパティーを設定します。

listeners=CONTROLLER://0.0.0.0:9090,REPLICATION://0.0.0.0:9091 ... control.plane.listener.name=CONTROLLER

listeners=CONTROLLER://0.0.0.0:9090,REPLICATION://0.0.0.0:9091

...

control.plane.listener.name=CONTROLLERコントロールプレーンのリスナーを有効にすると、コントローラーの通信がブローカー間でのデータレプリケーションによって遅延しないため、クラスターのパフォーマンスが向上する可能性があります。データレプリケーションは、ブローカー間リスナーを介して続行されます。

control.plane.listener が設定されていない場合、コントローラー接続には ブローカー間のリスナー が使用されます。

詳細は、「付録A ブローカー設定パラメーター」を参照してください。

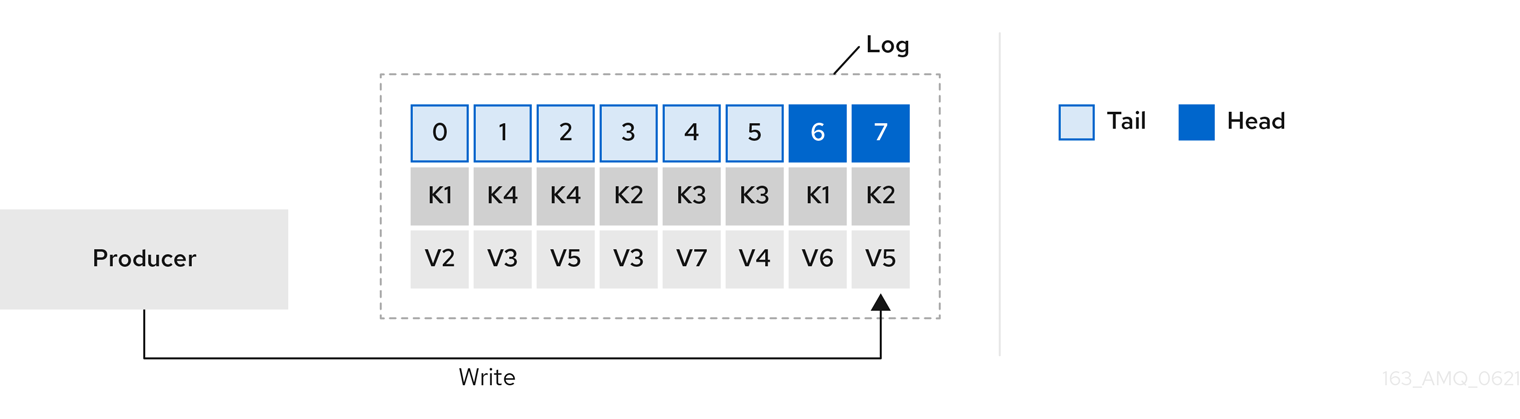

4.3. ログのコミット

Apache Kafka は、プロデューサーから受信するすべてのレコードをコミットログに保存します。コミットログには、Kafka が配信する必要のある実際のデータがレコードとして含まれます。これらは、ブローカーの動作を記録するアプリケーションログファイルではありません。

ログディレクトリー

log.dirs プロパティーファイルを使用してログディレクトリーを設定し、1 つまたは複数のログディレクトリーにコミットログを保存できます。これは、インストール時に作成された /var/lib/kafka ディレクトリーに設定する必要があります。

log.dirs=/var/lib/kafka

log.dirs=/var/lib/kafkaパフォーマンス上の理由から、log.dir を複数のディレクトリーに設定し、それぞれを異なる物理デバイスに配置して、ディスク I/O のパフォーマンスを向上させることができます。以下に例を示します。

log.dirs=/var/lib/kafka1,/var/lib/kafka2,/var/lib/kafka3

log.dirs=/var/lib/kafka1,/var/lib/kafka2,/var/lib/kafka34.4. ブローカー ID

ブローカー ID は、クラスター内の各ブローカーの一意の ID です。ブローカー ID として 0 以上の整数を割り当てることができます。ブローカー ID は、再起動またはクラッシュ後にブローカーを特定するために使用されます。そのため、ID が安定し、時間の経過とともに変更されないことが重要になります。ブローカー ID はブローカーのプロパティーファイルで設定されます。

broker.id=1

broker.id=14.5. マルチノードの Kafka クラスターの実行

この手順では、Kafka をマルチノードクラスターとして設定、実行する方法を説明します。

前提条件

- AMQ Streams が、Kafka ブローカーとして使用されるすべてのホストに インストールされている。

- ZooKeeper クラスターが 設定済みで実行されている。

クラスターの実行

AMQ Streams クラスターの各 Kafka ブローカーに対して以下を行います。

以下のように

/opt/kafka/config/server.propertiesKafka 設定ファイルを編集します。-

最初のブローカーの

broker.idフィールドを0に、2 番目のブローカーを1に、それぞれ設定します。 -

zookeeper.connectオプションで ZooKeeper への接続の詳細を設定します。 - Kafka リスナーを設定します。

logs.dirのディレクトリーに、コミットログが保存されるディレクトリーを設定します。以下は、Kafka ブローカーの設定例です。

broker.id=0 zookeeper.connect=zoo1.my-domain.com:2181,zoo2.my-domain.com:2181,zoo3.my-domain.com:2181 listeners=REPLICATION://:9091,PLAINTEXT://:9092 inter.broker.listener.name=REPLICATION log.dirs=/var/lib/kafka

broker.id=0 zookeeper.connect=zoo1.my-domain.com:2181,zoo2.my-domain.com:2181,zoo3.my-domain.com:2181 listeners=REPLICATION://:9091,PLAINTEXT://:9092 inter.broker.listener.name=REPLICATION log.dirs=/var/lib/kafkaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 各 Kafka ブローカーが同じハードウェアで実行されている通常のインストールでは、

broker.id設定プロパティーのみがブローカー設定ごとに異なります。

-

最初のブローカーの

デフォルトの設定ファイルで Kafka ブローカーを起動します。

su - kafka /opt/kafka/bin/kafka-server-start.sh -daemon /opt/kafka/config/server.properties

su - kafka /opt/kafka/bin/kafka-server-start.sh -daemon /opt/kafka/config/server.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow Kafka ブローカーが稼働していることを確認します。

jcmd | grep Kafka

jcmd | grep KafkaCopy to Clipboard Copied! Toggle word wrap Toggle overflow

ブローカーの検証

クラスターのすべてのノードが稼働したら、ncat ユーティリティーを使用して dump コマンドを ZooKeeper ノードのいずれかに送信して、すべてのノードが Kafka クラスターのメンバーであることを確認します。このコマンドは、ZooKeeper に登録されているすべての Kafka ブローカーを出力します。

ncat stat を使用してノードのステータスを確認します。

echo dump | ncat zoo1.my-domain.com 2181

echo dump | ncat zoo1.my-domain.com 2181Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力には、ここで設定および起動したすべての Kafka ブローカーが含まれているはずです。

3 つのノードで構成される Kafka クラスターの

ncatコマンドの出力例Copy to Clipboard Copied! Toggle word wrap Toggle overflow

その他のリソース

- AMQ Streams のインストールに関する詳細は、「AMQ Streams のインストール」を参照してください。

- AMQ Streams の設定に関する詳細は、「AMQ Streams の設定」を参照してください。

- ZooKeeper クラスターの実行に関する詳細は、「マルチノードの ZooKeeper クラスターの実行」を参照してください。

- サポートされる Kafka ブローカー設定オプションの完全リストは、「付録A ブローカー設定パラメーター」を参照してください。

4.6. ZooKeeper の認証

デフォルトでは、ZooKeeper と Kafka 間の接続は認証されません。ただし、Kafka および ZooKeeper は、Simple Authentication and Security Layer (SASL) を使用して認証を設定するのに使用できる Java Authentication and Authorization Service (JAAS) をサポートします。ZooKeeper は、ローカルに保存されたクレデンシャルで DIGEST-MD5 SASL メカニズムを使用する認証をサポートします。

4.6.1. JAAS 設定

ZooKeeper 接続の SASL 認証は、JAAS 設定ファイルで設定する必要があります。デフォルトでは、Kafka は ZooKeeper への接続用に Client という名前の JAAS コンテキストを使用します。Client コンテキストは、/opt/kafka/config/jass.conf ファイルで設定する必要があります。以下の例のように、コンテキストでは PLAIN SASL 認証を有効にする必要があります。

Client {

org.apache.kafka.common.security.plain.PlainLoginModule required

username="kafka"

password="123456";

};

Client {

org.apache.kafka.common.security.plain.PlainLoginModule required

username="kafka"

password="123456";

};4.6.2. ZooKeeper 認証の有効化

この手順では、ZooKeeper に接続する際に SASL DIGEST-MD5 メカニズムを使用した認証を有効にする方法を説明します。

前提条件

- ZooKeeper でクライアント/サーバー間の認証が 有効である。

SASL DIGEST-MD5 認証の有効化

すべての Kafka ブローカーノードで、

/opt/kafka/config/jaas.confJAAS 設定ファイルを作成または編集し、以下のコンテキストを追加します。Client { org.apache.kafka.common.security.plain.PlainLoginModule required username="<Username>" password="<Password>"; };Client { org.apache.kafka.common.security.plain.PlainLoginModule required username="<Username>" password="<Password>"; };Copy to Clipboard Copied! Toggle word wrap Toggle overflow ユーザー名とパスワードは ZooKeeper で設定されているものと同じである必要があります。

Clientコンテキストの例を以下に示します。Client { org.apache.kafka.common.security.plain.PlainLoginModule required username="kafka" password="123456"; };Client { org.apache.kafka.common.security.plain.PlainLoginModule required username="kafka" password="123456"; };Copy to Clipboard Copied! Toggle word wrap Toggle overflow すべての Kafka ブローカーノードを 1 つずつ再起動します。JAAS 設定を Kafka ブローカーに渡すには、

KAFKA_OPTS環境変数を使用します。su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/jaas.conf"; /opt/kafka/bin/kafka-server-start.sh -daemon /opt/kafka/config/server.properties

su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/jaas.conf"; /opt/kafka/bin/kafka-server-start.sh -daemon /opt/kafka/config/server.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

その他のリソース

- ZooKeeper でのクライアント/サーバー間の認証の設定に関する詳細は、「認証」を参照してください。

4.7. 承認

Kafka ブローカーの承認は、オーソライザープラグインを使用して実装されます。

本セクションでは、Kafka で提供される AclAuthorizer プラグインを使用する方法を説明します。

または、独自の承認プラグインを使用できます。たとえば、OAuth 2.0 トークンベースの認証 を使用している場合、OAuth 2.0 承認 を使用できます。

4.7.1. シンプルな ACL オーソライザー

AclAuthorizer を含むオーソライザープラグインは、authorizer.class.name プロパティーにより有効になります。

authorizer.class.name=kafka.security.auth.SimpleAclAuthorizer

authorizer.class.name=kafka.security.auth.SimpleAclAuthorizer

選択されたオーソライザーの完全修飾名が必要です。AclAuthorizer の場合、完全修飾名は kafka.security.auth.SimpleAclAuthorizer です。

4.7.1.1. ACL ルール

AclAuthorizer は、ACL ルールを使用して Kafka ブローカーへのアクセスを管理します。

ACL ルールは以下の形式で定義されます。

プリンシパル P は、ホスト H から Kafka リソース R に対する操作 O が許可/禁止される。

たとえば、以下のようにルールを設定します。

ユーザー John は、ホスト 127.0.0.1 からトピック コメント を 表示する ことができる。

ホストは、John が接続しているマシンの IP アドレスです。

ほとんどの場合、ユーザーはプロデューサーまたはコンシューマーアプリケーションです。

Consumer01 は、ホスト 127.0.0.1 からコンシューマーグループ アカウント に 書き込む ことができる。

ACL ルールが存在しない場合

特定のリソースに ACL ルールが存在しない場合は、すべてのアクションが拒否されます。この動作は、Kafka 設定ファイル /opt/kafka/config/server.properties で allow.everyone.if.no.acl.found プロパティーを true に設定すると変更できます。

4.7.1.2. プリンシパル

プリンシパル はユーザーのアイデンティティーを表します。ID の形式は、クライアントが Kafka に接続するために使用する認証メカニズムによって異なります。

-

User:ANONYMOUS: 認証なしで接続する場合。 User:<username>: PLAIN や SCRAM などの単純な認証メカニズムを使用して接続する場合。例:

User:adminまたはUser:user1User:<DistinguishedName>: TLS クライアント認証を使用して接続する場合。例:

User:CN=user1,O=MyCompany,L=Prague,C=CZ-

User:<Kerberos username>: Kerberos を使用して接続する場合。

DistinguishedName はクライアント証明書からの識別名です。

Kerberos ユーザー名 は Kerberos プリンシパルの主要部分で、Kerberos を使用して接続するときにデフォルトで使用されます。sasl.kerberos.principal.to.local.rules プロパティーを使用して、Kerberos プリンシパルから Kafka プリンシパルを構築する方法を設定できます。

4.7.1.3. ユーザーの認証

承認を使用するには、認証を有効にし、クライアントにより使用される必要があります。そうでないと、すべての接続のプリンシパルは User:ANONYMOUS になります。

認証方法の詳細は、「暗号化と認証」を参照してください。

4.7.1.4. スーパーユーザー

スーパーユーザーは、ACL ルールに関係なくすべてのアクションを実行できます。

スーパーユーザーは、super.users プロパティーを使用して Kafka 設定ファイルで定義されます。

以下に例を示します。

super.users=User:admin,User:operator

super.users=User:admin,User:operator4.7.1.5. レプリカブローカーの認証

承認を有効にすると、これはすべてのリスナーおよびすべての接続に適用されます。これには、ブローカー間のデータのレプリケーションに使用されるブローカー間の接続が含まれます。そのため、承認が有効になっている場合は、ブローカー間の接続に認証を使用し、ブローカーが使用するユーザーに十分な権限を付与してください。たとえば、ブローカー間の認証で kafka-broker ユーザーが使用される場合、スーパーユーザー設定にはユーザー名 super.users=User:kafka-broker が含まれている必要があります。

4.7.1.6. サポートされるリソース

Kafka ACL は、以下のようなタイプのリソースに適用できます。

- トピック

- コンシューマーグループ

- クラスター

- TransactionId

- DelegationToken

4.7.1.7. サポートされる操作

AclAuthorizer はリソースでの操作を承認します。

以下の表で X の付いたフィールドは、各リソースでサポートされる操作を表します。

| トピック | コンシューマーグループ | クラスター | |

|---|---|---|---|

| Read | X | X | |

| Write | X | ||

| Create | X | ||

| Delete | X | ||

| Alter | X | ||

| Describe | X | X | X |

| ClusterAction | X | ||

| All | X | X | X |

4.7.1.8. ACL 管理オプション

ACL ルールは、Kafka ディストリビューションパッケージの一部として提供される bin/kafka-acls.sh ユーティリティーを使用して管理されます。

kafka-acls.sh パラメーターオプションを使用して、ACL ルールを追加、一覧表示、および削除したり、その他の機能を実行したりします。

パラメーターには、--add など、二重ハイフンの標記が必要です。

| オプション | 型 | 説明 | デフォルト |

|---|---|---|---|

|

| アクション | ACL ルールを追加します。 | |

|

| アクション | ACL ルールを削除します。 | |

|

| アクション | ACL ルールを一覧表示します。 | |

|

| アクション | オーソライザーの完全修飾クラス名。 |

|

|

| 設定 | 初期化のためにオーソライザーに渡されるキー/値のペア。

| |

|

| リソース | Kafka クラスターに接続するためのホスト/ポートのペア。 |

このオプションまたは |

|

| リソース |

管理クライアントに渡す設定プロパティーファイル。これは | |

|

| リソース | クラスターを ACL リソースとして指定します。 | |

|

| リソース | トピック名を ACL リソースとして指定します。

ワイルドカードとして使用されるアスタリスク (

1 つのコマンドに複数の | |

|

| リソース | コンシューマーグループ名を ACL リソースとして指定します。

1 つのコマンドに複数の | |

|

| リソース | トランザクション ID を ACL リソースとして指定します。 トランザクション配信は、プロデューサーによって複数のパーティションに送信されたすべてのメッセージが正常に配信されるか、いずれも配信されない必要があることを意味します。

ワイルドカードとして使用されるアスタリスク ( | |

|

| リソース | 委譲トークンを ACL リソースとして指定します。

ワイルドカードとして使用されるアスタリスク ( | |

|

| 設定 |

|

|

|

| プリンシパル | 許可 ACL ルールに追加されるプリンシパル。

1 つのコマンドに複数の | |

|

| プリンシパル | 拒否 ACL ルールに追加されるプリンシパル。

1 つのコマンドに複数の | |

|

| プリンシパル |

プリンシパルの ACL の一覧を返すために

1 つのコマンドに複数の | |

|

| ホスト |

ホスト名または CIDR 範囲はサポートされていません。 |

|

|

| ホスト |

ホスト名または CIDR 範囲はサポートされていません。 |

|

|

| 操作 | 操作を許可または拒否します。

1 つのコマンドに複数の | All |

|

| ショートカット | メッセージプロデューサーが必要とするすべての操作を許可または拒否するショートカット (トピックでの WRITE および DESCRIBE、クラスターでの CREATE)。 | |

|

| ショートカット | メッセージコンシューマーが必要とするすべての操作を許可または拒否するショートカット (トピックでの READ および DESCRIBE、コンシューマーグループでの READ)。 | |

|

| ショートカット |

特定のトランザクション ID に基づいてメッセージを送信するようにプロデューサーが承認されている場合、冪等性は自動的に有効になります。 | |

|

| ショートカット | すべてのクエリーを受け入れ、プロンプトは表示されないショートカット。 |

4.7.2. 承認の有効化

この手順では、Kafka ブローカーでの承認用に AclAuthorizer プラグインを有効にする方法を説明します。

前提条件

- Kafka ブローカーとして使用されるすべてのホストに AMQ Streams がインストールされている。

手順

/opt/kafka/config/server.propertiesKafka 設定ファイルを編集してAclAuthorizerを使用します。authorizer.class.name=kafka.security.auth.SimpleAclAuthorizer

authorizer.class.name=kafka.security.auth.SimpleAclAuthorizerCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Kafka ブローカーを (再) 起動します。

その他のリソース

- AMQ Streams の設定に関する詳細は、「AMQ Streams の設定」を参照してください。

- Kafka クラスターの実行に関する詳細は、「マルチノードの Kafka クラスターの実行」を参照してください。

4.7.3. ACL ルールの追加

AclAuthorizer は、ユーザーが実行できる/できない操作を記述するルールのセットを定義するアクセス制御リスト (ACL) を使用します。

この手順では、Kafka ブローカーで AclAuthorizer プラグインを使用する場合に、ACL ルールを追加する方法を説明します。

ルールは kafka-acls.sh ユーティリティーを使用して追加され、ZooKeeper に保存されます。

前提条件

- Kafka ブローカーとして使用されるすべてのホストに AMQ Streams がインストールされている。

- Kafka ブローカーで承認が 有効である。

手順

--addオプションを指定してkafka-acls.shを実行します。以下に例を示します。

MyConsumerGroupコンシューマーグループを使用してmyTopicからのuser1およびuser2の読み取りアクセスを許可します。bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --add --operation Read --topic myTopic --allow-principal User:user1 --allow-principal User:user2 bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --add --operation Describe --topic myTopic --allow-principal User:user1 --allow-principal User:user2 bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --add --operation Read --operation Describe --group MyConsumerGroup --allow-principal User:user1 --allow-principal User:user2

bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --add --operation Read --topic myTopic --allow-principal User:user1 --allow-principal User:user2 bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --add --operation Describe --topic myTopic --allow-principal User:user1 --allow-principal User:user2 bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --add --operation Read --operation Describe --group MyConsumerGroup --allow-principal User:user1 --allow-principal User:user2Copy to Clipboard Copied! Toggle word wrap Toggle overflow IP アドレスホスト

127.0.0.1からのmyTopicへのuser1の読み取りアクセスを拒否します。bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --add --operation Describe --operation Read --topic myTopic --group MyConsumerGroup --deny-principal User:user1 --deny-host 127.0.0.1

bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --add --operation Describe --operation Read --topic myTopic --group MyConsumerGroup --deny-principal User:user1 --deny-host 127.0.0.1Copy to Clipboard Copied! Toggle word wrap Toggle overflow MyConsumerGroupを使用して、myTopicのコンシューマーとしてuser1を追加します。bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --add --consumer --topic myTopic --group MyConsumerGroup --allow-principal User:user1

bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --add --consumer --topic myTopic --group MyConsumerGroup --allow-principal User:user1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

その他のリソース

-

すべての

kafka-acls.shオプションの一覧は、「シンプルな ACL オーソライザー」を参照してください。

4.7.4. ACL ルールの一覧表示

この手順では、Kafka ブローカーで AclAuthorizer プラグインを使用する場合に、既存の ACL ルールを一覧表示する方法を説明します。

ルールは、kafka-acls.sh ユーティリティーを使用してリストされます。

前提条件

- Kafka ブローカーとして使用されるすべてのホストに AMQ Streams がインストールされている。

- Kafka ブローカーで承認が 有効である。

- ACL が 追加されている。

手順

--listオプションを指定してkafka-acls.shを実行します。以下に例を示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

その他のリソース

-

すべての

kafka-acls.shオプションの一覧は、「シンプルな ACL オーソライザー」を参照してください。

4.7.5. ACL ルールの削除

この手順では、Kafka ブローカーで AclAuthorizer プラグインを使用する場合に、ACL ルールを削除する方法を説明します。

ルールは、kafka-acls.sh ユーティリティーを使用して削除されます。

前提条件

- Kafka ブローカーとして使用されるすべてのホストに AMQ Streams がインストールされている。

- Kafka ブローカーで承認が 有効である。

- ACL が 追加されている。

手順

--removeオプションを指定してkafka-acls.shを実行します。以下に例を示します。

MyConsumerGroupコンシューマーグループを使用してmyTopicからのuser1およびuser2の読み取りアクセスを許可する ACL を削除します。bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --remove --operation Read --topic myTopic --allow-principal User:user1 --allow-principal User:user2 bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --remove --operation Describe --topic myTopic --allow-principal User:user1 --allow-principal User:user2 bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --remove --operation Read --operation Describe --group MyConsumerGroup --allow-principal User:user1 --allow-principal User:user2

bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --remove --operation Read --topic myTopic --allow-principal User:user1 --allow-principal User:user2 bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --remove --operation Describe --topic myTopic --allow-principal User:user1 --allow-principal User:user2 bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --remove --operation Read --operation Describe --group MyConsumerGroup --allow-principal User:user1 --allow-principal User:user2Copy to Clipboard Copied! Toggle word wrap Toggle overflow MyConsumerGroupを使用してmyTopicのコンシューマーとしてuser1を追加する ACL を削除します。bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --remove --consumer --topic myTopic --group MyConsumerGroup --allow-principal User:user1

bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --remove --consumer --topic myTopic --group MyConsumerGroup --allow-principal User:user1Copy to Clipboard Copied! Toggle word wrap Toggle overflow IP アドレスホスト

127.0.0.1からのmyTopicへのuser1の読み取りアクセスを拒否する ACL を削除します。bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --remove --operation Describe --operation Read --topic myTopic --group MyConsumerGroup --deny-principal User:user1 --deny-host 127.0.0.1

bin/kafka-acls.sh --authorizer-properties zookeeper.connect=zoo1.my-domain.com:2181 --remove --operation Describe --operation Read --topic myTopic --group MyConsumerGroup --deny-principal User:user1 --deny-host 127.0.0.1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

その他のリソース

-

すべての

kafka-acls.shオプションの一覧は、「シンプルな ACL オーソライザー」を参照してください。 - 承認の有効化に関する詳細は、「承認の有効化」を参照してください。

4.8. ZooKeeper の承認

Kafka と ZooKeeper との間で認証が有効になっていると、ZooKeeper アクセス制御リスト (ACL) ルールを使用して、ZooKeeper に保存された Kafka メタデータへのアクセスを自動的に制御できます。

4.8.1. ACL 設定

ZooKeeper ACL ルールの適用は、config/server.properties Kafka 設定ファイルの zookeeper.set.acl プロパティーによって制御されます。

プロパティーはデフォルトで無効になっていて、true に設定することにより有効になります。

zookeeper.set.acl=true

zookeeper.set.acl=true

ACL ルールが有効になっている場合、ZooKeeper で znode が作成されると、作成した Kafka ユーザーのみが変更または削除できます。その他のすべてのユーザーには、読み取り専用アクセスが付与されます。

Kafka は、新しく作成された ZooKeeper znodes に対してのみ ACL ルールを設定します。ACL がクラスターの最初の起動後にのみ有効である場合、zookeeper-security-migration.sh ツールは既存のすべての znodes に ACL を設定できます。

ZooKeeper のデータの機密性

ZooKeeper に保存されるデータには以下が含まれます。

- トピック名およびその設定

- SASL SCRAM 認証が使用される場合に、ソルトおよびハッシュ化されたユーザークレデンシャル

しかし、ZooKeeper は Kafka を使用して送受信されるレコードを保存しません。ZooKeeper に保存されるデータは機密ではないと仮定されます。

データが機密として考慮される場合 (たとえば、トピック名にカスタマー ID が含まれる場合など)、データ保護に使用できる唯一のオプションは、ネットワークレベルで ZooKeeper を分離し、Kafka ブローカーにのみアクセスを許可することです。

4.8.2. 新しい Kafka クラスターでの ZooKeeper ACL の有効化

この手順では、新しい Kafka クラスターの Kafka 設定で ZooKeeper ACL を有効にする方法を説明します。この手順は、Kafka クラスターの最初の起動前にのみ使用してください。すでに実行中のクラスターで ZooKeeper ACL を有効にする場合は、「既存の Kafka クラスターでの ZooKeeper ACL の有効化」を参照してください。

前提条件

- AMQ Streams が、Kafka ブローカーとして使用されるすべてのホストに インストールされている。

- ZooKeeper クラスターが 設定済みで実行されている。

- ZooKeeper で、クライアント/サーバー間の認証が 有効である。

- Kafka ブローカーで ZooKeeper の認証が 有効である。

- Kafka ブローカーがまだ起動していない。

手順

/opt/kafka/config/server.propertiesKafka 設定ファイルを編集して、すべてのクラスターノードのzookeeper.set.aclフィールドをtrueに設定します。zookeeper.set.acl=true

zookeeper.set.acl=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Kafka ブローカーを起動します。

4.8.3. 既存の Kafka クラスターでの ZooKeeper ACL の有効化

この手順では、実行中の Kafka クラスターの Kafka 設定で ZooKeeper ACL を有効にする方法を説明します。zookeeper-security-migration.sh ツールを使用して、すべての既存の znodes に ZooKeeper ACL を設定します。zookeeper-security-migration.sh は AMQ Streams の一部として利用でき、bin ディレクトリーにあります。

前提条件

- Kafka クラスターが 設定済みで実行されている。

ZooKeeper ACL の有効化

/opt/kafka/config/server.propertiesKafka 設定ファイルを編集して、すべてのクラスターノードのzookeeper.set.aclフィールドをtrueに設定します。zookeeper.set.acl=true

zookeeper.set.acl=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow - すべての Kafka ブローカーを 1 つずつ再起動します。

zookeeper-security-migration.shツールを使用して、すべての既存の ZooKeeperznodesに ACL を設定します。su - kafka cd /opt/kafka KAFKA_OPTS="-Djava.security.auth.login.config=./config/jaas.conf"; ./bin/zookeeper-security-migration.sh --zookeeper.acl=secure --zookeeper.connect=<ZooKeeperURL> exit

su - kafka cd /opt/kafka KAFKA_OPTS="-Djava.security.auth.login.config=./config/jaas.conf"; ./bin/zookeeper-security-migration.sh --zookeeper.acl=secure --zookeeper.connect=<ZooKeeperURL> exitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

su - kafka cd /opt/kafka KAFKA_OPTS="-Djava.security.auth.login.config=./config/jaas.conf"; ./bin/zookeeper-security-migration.sh --zookeeper.acl=secure --zookeeper.connect=zoo1.my-domain.com:2181 exit

su - kafka cd /opt/kafka KAFKA_OPTS="-Djava.security.auth.login.config=./config/jaas.conf"; ./bin/zookeeper-security-migration.sh --zookeeper.acl=secure --zookeeper.connect=zoo1.my-domain.com:2181 exitCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.9. 暗号化と認証

AMQ Streams は暗号化および認証をサポートします。これらは、リスナー設定の一部として設定されます。

4.9.1. リスナーの設定

Kafka ブローカーの暗号化および認証は、リスナーごとに設定されます。Kafka リスナーの設定に関する詳細は、「リスナー」を参照してください。

Kafka ブローカーの各リスナーは、独自のセキュリティープロトコルで設定されます。設定プロパティー listener.security.protocol.map は、どのリスナーがどのセキュリティープロトコルを使用するかを定義します。各リスナー名がセキュリティープロトコルにマッピングされます。サポートされるセキュリティープロトコルは次のとおりです。

PLAINTEXT- 暗号化または認証を使用しないリスナー。

SSL- TLS 暗号化を使用し、オプションとして TLS クライアント証明書による認証を使用するリスナー。

SASL_PLAINTEXT- 暗号化は使用しないが、SASL ベースの認証を使用するリスナー。

SASL_SSL- TLS ベースの暗号化および SASL ベースの認証を使用するリスナー。

以下の listeners 設定の場合、

listeners=INT1://:9092,INT2://:9093,REPLICATION://:9094

listeners=INT1://:9092,INT2://:9093,REPLICATION://:9094

listener.security.protocol.map は以下のようになります。

listener.security.protocol.map=INT1:SASL_PLAINTEXT,INT2:SASL_SSL,REPLICATION:SSL

listener.security.protocol.map=INT1:SASL_PLAINTEXT,INT2:SASL_SSL,REPLICATION:SSL

これにより、リスナー INT1 は暗号化されていない接続および SASL 認証を使用し、リスナー INT2 は暗号化された接続および SASL 認証を使用し、REPLICATION インターフェースは TLS による暗号化 (TLS クライアント認証が使用される可能性があり) を使用するように設定されます。同じセキュリティープロトコルを複数回使用できます。以下も、有効な設定の例です。

listener.security.protocol.map=INT1:SSL,INT2:SSL,REPLICATION:SSL

listener.security.protocol.map=INT1:SSL,INT2:SSL,REPLICATION:SSLこのような設定は、すべてのインターフェースに TLS による暗号化および TLS 認証を使用します。以下の章では、TLS および SASL の設定方法について詳しく説明します。

4.9.2. TLS 暗号化

Kafka は、Kafka クライアントとの通信を暗号化するために TLS をサポートします。

TLS による暗号化およびサーバー認証を使用するには、秘密鍵と公開鍵が含まれるキーストアを提供する必要があります。これは通常、Java Keystore (JKS) 形式のファイルを使用して行われます。このファイルへのパスは ssl.keystore.location プロパティーで設定されます。ssl.keystore.password プロパティーを使用して、キーストアを保護するパスワードを設定する必要があります。以下に例を示します。

ssl.keystore.location=/path/to/keystore/server-1.jks ssl.keystore.password=123456

ssl.keystore.location=/path/to/keystore/server-1.jks

ssl.keystore.password=123456

秘密鍵を保護するために、追加のパスワードを使用することがあります。このようなパスワードは、ssl.key.password プロパティーを使用して設定できます。

Kafka では、認証局が署名した鍵に加えて自己署名の鍵を使用できます。認証局が署名する鍵を使用することが、常に推奨の方法です。クライアントが接続している Kafka ブローカーのアイデンティティーを確認できるようにするには、証明書に Common Name (CN) または Subject Alternative Names (SAN) としてアドバタイズされたホスト名を常に含める必要があります。

異なるリスナーに異なる SSL 設定を使用できます。ssl. で始まるすべてのオプションの前に listener.name.<NameOfTheListener>. を付けることができます。この場合、リスナーの名前は常に小文字である必要があります。これにより、その特定リスナーのデフォルトの SSL 設定が上書きされます。以下の例は、異なるリスナーに異なる SSL 設定を使用する方法を示しています。

その他の TLS 設定オプション

上記のメインの TLS 設定オプションに加え、Kafka は TLS 設定を調整するための多くのオプションをサポートします。たとえば、TLS/ SSL プロトコルまたは暗号スイートを有効または無効にする場合を以下に示します。

ssl.cipher.suites- 有効な暗号スイートの一覧それぞれの暗号スイートは、TLS 接続に使用される認証、暗号化、MAC、およびキー交換アルゴリズムの組み合わせです。デフォルトでは、利用可能なすべての暗号スイートが有効になっています。

ssl.enabled.protocols-

有効な TLS / SSL プロトコルのリスト。デフォルトは

TLSv1.2,TLSv1.1,TLSv1です。

サポートされる Kafka ブローカー設定オプションの完全リストは、「付録A ブローカー設定パラメーター」を参照してください。

4.9.3. TLS 暗号化の有効化

この手順では、Kafka ブローカーで暗号化を有効にする方法を説明します。

前提条件

- AMQ Streams が、Kafka ブローカーとして使用されるすべてのホストに インストールされている。

手順

- クラスター内のすべての Kafka ブローカーの TLS 証明書を生成します。証明書には、Common Name または Subject Alternative Name のアドバタイズされたアドレスおよびブートストラップアドレスが必要です。

以下のように、すべてのクラスターノードの

/opt/kafka/config/server.propertiesKafka 設定ファイルを編集します。-

listener.security.protocol.mapフィールドを変更して、TLS 暗号化を使用するリスナーにSSLプロトコルを指定します。 -

ssl.keystore.locationオプションを、ブローカー証明書を持つ JKS キーストアへのパスに設定します。 ssl.keystore.passwordオプションを、キーストアの保護に使用したパスワードに設定します。以下に例を示します。

listeners=UNENCRYPTED://:9092,ENCRYPTED://:9093,REPLICATION://:9094 listener.security.protocol.map=UNENCRYPTED:PLAINTEXT,ENCRYPTED:SSL,REPLICATION:PLAINTEXT ssl.keystore.location=/path/to/keystore/server-1.jks ssl.keystore.password=123456

listeners=UNENCRYPTED://:9092,ENCRYPTED://:9093,REPLICATION://:9094 listener.security.protocol.map=UNENCRYPTED:PLAINTEXT,ENCRYPTED:SSL,REPLICATION:PLAINTEXT ssl.keystore.location=/path/to/keystore/server-1.jks ssl.keystore.password=123456Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

- Kafka ブローカーを (再) 起動します。

その他のリソース

- AMQ Streams の設定に関する詳細は、「AMQ Streams の設定」を参照してください。

- Kafka クラスターの実行に関する詳細は、「マルチノードの Kafka クラスターの実行」を参照してください。

クライアントでの TLS 暗号化の設定に関する詳細は、以下を参照してください。

4.9.4. 認証

認証には、以下を使用できます。

- 暗号化接続の X.509 証明書に基づいた TLS クライアント認証

- サポートされる Kafka SASL (Simple Authentication and Security Layer) メカニズム

- OAuth 2.0 のトークンベースの認証

4.9.4.1. TLS クライアント認証

TLS クライアント認証は、すでに TLS 暗号化を使用している接続でのみ使用できます。TLS クライアント認証を使用するには、公開鍵のあるトラストストアをブローカーに提供できます。これらのキーは、ブローカーに接続するクライアントを認証するために使用できます。トラストストアは Java Keystore (JKS) 形式で提供され、認証局の公開鍵が含まれている必要があります。トラストストアに含まれる認証局のいずれかによって署名された公開鍵および秘密鍵を持つクライアントは、すべて認証されます。トラストストアの場所は、フィールド ssl.truststore.location を使用して設定されます。トラストストアがパスワードで保護される場合、ssl.truststore.password プロパティーでパスワードを設定する必要があります。以下に例を示します。

ssl.truststore.location=/path/to/keystore/server-1.jks ssl.truststore.password=123456

ssl.truststore.location=/path/to/keystore/server-1.jks

ssl.truststore.password=123456

トラストストアが設定したら、ssl.client.auth プロパティーを使用して TLS クライアント認証を有効にする必要があります。このプロパティーは、3 つの異なる値のいずれかに設定できます。

none- TLS クライアント認証は無効です (デフォルト値)。

requested- TLS クライアント認証は任意です。クライアントは TLS クライアント証明書を使用して認証するよう求められますが、それに従わない選択が可能です。

required- クライアントは TLS クライアント証明書を使用して認証することが要求されます。

クライアントが TLS クライアント認証を使用して認証する場合、認証されたプリンシパル名は認証済みクライアント証明書からの識別名になります。たとえば、識別名が CN=someuser の証明書を持つユーザーは、プリンシパル CN=someuser,OU=Unknown,O=Unknown,L=Unknown,ST=Unknown,C=Unknown で認証されます。TLS クライアント認証が使用されておらず、SASL が無効な場合、プリンシパル名は ANONYMOUS になります。

4.9.4.2. SASL 認証

SASL 認証は、Java Authentication and Authorization Service (JAAS) を使用して設定されます。JAAS は、Kafka と ZooKeeper との間の接続の認証にも使用されます。JAAS は独自の設定ファイルを使用します。このファイルに推奨される場所は /opt/kafka/config/jaas.conf です。ファイルは kafka ユーザーが読み取りできる必要があります。Kafka を実行中の場合、このファイルの場所は Java システムプロパティー java.security.auth.login.config を使用して指定されます。このプロパティーは、ブローカーノードの起動時に Kafka に渡す必要があります。

KAFKA_OPTS="-Djava.security.auth.login.config=/path/to/my/jaas.config"; bin/kafka-server-start.sh

KAFKA_OPTS="-Djava.security.auth.login.config=/path/to/my/jaas.config"; bin/kafka-server-start.sh

SASL 認証は、暗号化されていないプレーンの接続と TLS 接続の両方を介してサポートされます。SASL は各リスナーに対して個別に有効にできます。これを有効にするには、listener.security.protocol.map のセキュリティープロトコルを SASL_PLAINTEXT または SASL_SSL にする必要があります。

Kafka の SASL 認証は、さまざまなメカニズムをサポートします。

PLAIN- ユーザー名とパスワードを基に認証を実装します。ユーザー名およびパスワードは、Kafka 設定にローカルに保存されます。

SCRAM-SHA-256およびSCRAM-SHA-512- Salted Challenge Response Authentication Mechanism (SCRAM) を使用して認証を実装します。SCRAM クレデンシャルは、ZooKeeper に一元的に保存されます。SCRAM は、ZooKeeper クラスターノードがプライベートネットワークで分離された状態で実行される場合に使用できます。

GSSAPI- Kerberos サーバーに対して認証を実装します。

PLAIN メカニズムは、ネットワークを通じてユーザー名とパスワードを暗号化されていない形式で送信します。したがって、TLS による暗号化との組み合わせでのみ使用する必要があります。

SASL メカニズムは JAAS 設定ファイルを使用して設定されます。Kafka は KafkaServer という名前の JAAS コンテキストを使用します。JAAS で設定された後、Kafka 設定で SASL メカニズムを有効にする必要があります。これには、sasl.enabled.mechanisms プロパティーを使用します。このプロパティーには、有効なメカニズムのコンマ区切りリストが含まれます。

sasl.enabled.mechanisms=PLAIN,SCRAM-SHA-256,SCRAM-SHA-512

sasl.enabled.mechanisms=PLAIN,SCRAM-SHA-256,SCRAM-SHA-512

ブローカー間の通信に使用されるリスナーが SASL を使用している場合、sasl.mechanism.inter.broker.protocol プロパティーを使用して使用する SASL メカニズムを指定する必要があります。以下に例を示します。

sasl.mechanism.inter.broker.protocol=PLAIN

sasl.mechanism.inter.broker.protocol=PLAIN

ブローカー間の通信に使用されるユーザー名およびパスワードは、フィールド username および password を使用して KafkaServer JAAS コンテキストで指定する必要があります。

SASL プレーン

PLAIN メカニズムを使用するには、接続が許可されるユーザー名およびパスワードは JAAS コンテキストに直接指定されます。以下の例は、SASL PLAIN 認証に設定されたコンテキストを示しています。この例では、3 人の異なるユーザーを設定します。

-

admin -

user1 -

user2

ユーザーデータベースを持つ JAAS 設定ファイルは、すべての Kafka ブローカーで同期した状態を維持する必要があります。

SASL PLAIN がブローカー間の認証にも使用される場合、username および password プロパティーを JAAS コンテキストに含める必要があります。

SASL SCRAM

Kafka の SCRAM 認証は、SCRAM-SHA-256 および SCRAM-SHA-512 の 2 つのメカニズムで構成されます。これらのメカニズムは、使用されるハッシュアルゴリズム (SHA-256 とより強力な SHA-512) が違うだけです。SCRAM 認証を有効にするには、JAAS 設定ファイルに以下の設定を含める必要があります。

KafkaServer {

org.apache.kafka.common.security.scram.ScramLoginModule required;

};

KafkaServer {

org.apache.kafka.common.security.scram.ScramLoginModule required;

};Kafka 設定ファイルで SASL 認証を有効にすると、両方の SCRAM メカニズムが一覧表示されます。ただし、それらの 1 つのみをブローカー間の通信に選択できます。以下に例を示します。

sasl.enabled.mechanisms=SCRAM-SHA-256,SCRAM-SHA-512 sasl.mechanism.inter.broker.protocol=SCRAM-SHA-512

sasl.enabled.mechanisms=SCRAM-SHA-256,SCRAM-SHA-512

sasl.mechanism.inter.broker.protocol=SCRAM-SHA-512

SCRAM メカニズムのユーザークレデンシャルは ZooKeeper に保存されます。kafka-configs.sh ツールを使用してそれらを管理することができます。たとえば、以下のコマンドを実行して、パスワード 123456 で user1 を追加します。

bin/kafka-configs.sh --bootstrap-server localhost:9092 --alter --add-config 'SCRAM-SHA-256=[password=123456],SCRAM-SHA-512=[password=123456]' --entity-type users --entity-name user1

bin/kafka-configs.sh --bootstrap-server localhost:9092 --alter --add-config 'SCRAM-SHA-256=[password=123456],SCRAM-SHA-512=[password=123456]' --entity-type users --entity-name user1ユーザークレデンシャルを削除するには、以下のコマンドを使用します。

bin/kafka-configs.sh --bootstrap-server localhost:9092 --alter --delete-config 'SCRAM-SHA-512' --entity-type users --entity-name user1

bin/kafka-configs.sh --bootstrap-server localhost:9092 --alter --delete-config 'SCRAM-SHA-512' --entity-type users --entity-name user1SASL GSSAPI

Kerberos を使用した認証に使用される SASL メカニズムは GSSAPI と呼ばれます。Kerberos SASL 認証を設定するには、以下の設定を JAAS 設定ファイルに追加する必要があります。

Kerberos プリンシパルのドメイン名は、常に大文字にする必要があります。

JAAS 設定の他に、Kerberos サービス名を Kafka 設定の sasl.kerberos.service.name プロパティーで指定する必要があります。

sasl.enabled.mechanisms=GSSAPI sasl.mechanism.inter.broker.protocol=GSSAPI sasl.kerberos.service.name=kafka

sasl.enabled.mechanisms=GSSAPI

sasl.mechanism.inter.broker.protocol=GSSAPI

sasl.kerberos.service.name=kafkaマルチ SASL メカニズム

Kafka は、複数の SASL メカニズムを同時に使用できます。異なる JAAS 設定はすべて、同じコンテキストに追加できます。

複数のメカニズムを有効にすると、クライアントは使用するメカニズムを選択できます。

4.9.5. TLS クライアント認証の有効化

この手順では、Kafka ブローカーで TLS クライアント認証を有効にする方法を説明します。

前提条件

- AMQ Streams が、Kafka ブローカーとして使用されるすべてのホストに インストールされている。

- TLS 暗号化が 有効である。

手順

- ユーザー証明書に署名するために使用される認証局の公開鍵が含まれる JKS トラストストアを準備します。

以下のように、すべてのクラスターノードの

/opt/kafka/config/server.propertiesKafka 設定ファイルを編集します。-

ssl.truststore.locationオプションを、ユーザー証明書の認証局が含まれる JKS トラストストアへのパスに設定します。 -

ssl.truststore.passwordオプションを、トラストストアの保護に使用したパスワードに設定します。 ssl.client.authオプションをrequiredに設定します。以下に例を示します。

ssl.truststore.location=/path/to/truststore.jks ssl.truststore.password=123456 ssl.client.auth=required

ssl.truststore.location=/path/to/truststore.jks ssl.truststore.password=123456 ssl.client.auth=requiredCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

- Kafka ブローカーを (再) 起動します。

その他のリソース

- AMQ Streams の設定に関する詳細は、「AMQ Streams の設定」を参照してください。

- Kafka クラスターの実行に関する詳細は、「マルチノードの Kafka クラスターの実行」を参照してください。

クライアントでの TLS 暗号化の設定に関する詳細は、以下を参照してください。

4.9.6. SASL PLAIN 認証の有効化

この手順では、Kafka ブローカーで SASL PLAIN 認証を有効にする方法を説明します。

前提条件

- AMQ Streams が、Kafka ブローカーとして使用されるすべてのホストに インストールされている。

手順

/opt/kafka/config/jaas.confJAAS 設定ファイルを編集するか、または作成します。このファイルには、すべてのユーザーとユーザーのパスワードが含まれている必要があります。このファイルがすべての Kafka ブローカーで同じであるようにします。以下に例を示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のように、すべてのクラスターノードの

/opt/kafka/config/server.propertiesKafka 設定ファイルを編集します。-

listener.security.protocol.mapフィールドを変更して、SASL PLAIN 認証を使用するリスナーにSASL_PLAINTEXTまたはSASL_SSLプロトコルを指定します。 sasl.enabled.mechanismsオプションをPLAINに設定します。以下に例を示します。

listeners=INSECURE://:9092,AUTHENTICATED://:9093,REPLICATION://:9094 listener.security.protocol.map=INSECURE:PLAINTEXT,AUTHENTICATED:SASL_PLAINTEXT,REPLICATION:PLAINTEXT sasl.enabled.mechanisms=PLAIN

listeners=INSECURE://:9092,AUTHENTICATED://:9093,REPLICATION://:9094 listener.security.protocol.map=INSECURE:PLAINTEXT,AUTHENTICATED:SASL_PLAINTEXT,REPLICATION:PLAINTEXT sasl.enabled.mechanisms=PLAINCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

JAAS 設定を Kafka ブローカーに渡す KAFKA_OPTS 環境変数を使用して、Kafka ブローカーを (再) 起動します。

su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/jaas.conf"; /opt/kafka/bin/kafka-server-start.sh -daemon /opt/kafka/config/server.properties

su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/jaas.conf"; /opt/kafka/bin/kafka-server-start.sh -daemon /opt/kafka/config/server.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

その他のリソース

- AMQ Streams の設定に関する詳細は、「AMQ Streams の設定」を参照してください。

- Kafka クラスターの実行に関する詳細は、「マルチノードの Kafka クラスターの実行」を参照してください。

クライアントでの SASL PLAIN 認証の設定に関する詳細は、以下を参照してください。

4.9.7. SASL SCRAM 認証の有効化

この手順では、Kafka ブローカーで SASL SCRAM 認証を有効にする方法を説明します。

前提条件

- AMQ Streams が、Kafka ブローカーとして使用されるすべてのホストに インストールされている。

手順

/opt/kafka/config/jaas.confJAAS 設定ファイルを編集するか、または作成します。KafkaServerコンテキストのScramLoginModuleを有効にします。このファイルがすべての Kafka ブローカーで同じであるようにします。以下に例を示します。

KafkaServer { org.apache.kafka.common.security.scram.ScramLoginModule required; };KafkaServer { org.apache.kafka.common.security.scram.ScramLoginModule required; };Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のように、すべてのクラスターノードの

/opt/kafka/config/server.propertiesKafka 設定ファイルを編集します。-

listener.security.protocol.mapフィールドを変更して、SASL SCRAM 認証を使用するリスナーにSASL_PLAINTEXTまたはSASL_SSLプロトコルを指定します。 sasl.enabled.mechanismsオプションをSCRAM-SHA-256またはSCRAM-SHA-512に設定します。以下に例を示します。

listeners=INSECURE://:9092,AUTHENTICATED://:9093,REPLICATION://:9094 listener.security.protocol.map=INSECURE:PLAINTEXT,AUTHENTICATED:SASL_PLAINTEXT,REPLICATION:PLAINTEXT sasl.enabled.mechanisms=SCRAM-SHA-512

listeners=INSECURE://:9092,AUTHENTICATED://:9093,REPLICATION://:9094 listener.security.protocol.map=INSECURE:PLAINTEXT,AUTHENTICATED:SASL_PLAINTEXT,REPLICATION:PLAINTEXT sasl.enabled.mechanisms=SCRAM-SHA-512Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

JAAS 設定を Kafka ブローカーに渡す KAFKA_OPTS 環境変数を使用して、Kafka ブローカーを (再) 起動します。

su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/jaas.conf"; /opt/kafka/bin/kafka-server-start.sh -daemon /opt/kafka/config/server.properties

su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/jaas.conf"; /opt/kafka/bin/kafka-server-start.sh -daemon /opt/kafka/config/server.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

その他のリソース

- AMQ Streams の設定に関する詳細は、「AMQ Streams の設定」を参照してください。

- Kafka クラスターの実行に関する詳細は、「マルチノードの Kafka クラスターの実行」を参照してください。

- SASL SCRAM ユーザーの追加に関する詳細は、「SASL SCRAM ユーザーの追加」を参照してください。

- SASL SCRAM ユーザーの削除に関する詳細は、「SASL SCRAM ユーザーの削除」を参照してください。

クライアントでの SASL SCRAM 認証の設定に関する詳細は、以下を参照してください。

4.9.8. SASL SCRAM ユーザーの追加

この手順では、SASL SCRAM を使用する認証に新規ユーザーを追加する方法を説明します。

前提条件

- AMQ Streams が、Kafka ブローカーとして使用されるすべてのホストに インストールされている。

- SASL SCRAM 認証が 有効である。

手順

kafka-configs.shツールを使用して、新しい SASL SCRAM ユーザーを追加します。bin/kafka-configs.sh --bootstrap-server <BrokerAddress> --alter --add-config 'SCRAM-SHA-512=[password=<Password>]' --entity-type users --entity-name <Username>

bin/kafka-configs.sh --bootstrap-server <BrokerAddress> --alter --add-config 'SCRAM-SHA-512=[password=<Password>]' --entity-type users --entity-name <Username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

bin/kafka-configs.sh --bootstrap-server localhost:9092 --alter --add-config 'SCRAM-SHA-512=[password=123456]' --entity-type users --entity-name user1

bin/kafka-configs.sh --bootstrap-server localhost:9092 --alter --add-config 'SCRAM-SHA-512=[password=123456]' --entity-type users --entity-name user1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

その他のリソース

クライアントでの SASL SCRAM 認証の設定に関する詳細は、以下を参照してください。

4.9.9. SASL SCRAM ユーザーの削除

この手順では、SASL SCRAM 認証を使用する場合にユーザーを削除する方法を説明します。

前提条件

- AMQ Streams が、Kafka ブローカーとして使用されるすべてのホストに インストールされている。

- SASL SCRAM 認証が 有効である。

手順

kafka-configs.shツールを使用して、SASL SCRAM ユーザーを削除します。bin/kafka-configs.sh --bootstrap-server <BrokerAddress> --alter --delete-config 'SCRAM-SHA-512' --entity-type users --entity-name <Username>

bin/kafka-configs.sh --bootstrap-server <BrokerAddress> --alter --delete-config 'SCRAM-SHA-512' --entity-type users --entity-name <Username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

bin/kafka-configs.sh --bootstrap-server localhost:9092 --alter --delete-config 'SCRAM-SHA-512' --entity-type users --entity-name user1

bin/kafka-configs.sh --bootstrap-server localhost:9092 --alter --delete-config 'SCRAM-SHA-512' --entity-type users --entity-name user1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

その他のリソース

クライアントでの SASL SCRAM 認証の設定に関する詳細は、以下を参照してください。

4.10. OAuth 2.0 トークンベース認証の使用

AMQ Streams は、OAUTHBEARER および PLAIN メカニズムを使用して OAuth 2.0 認証の使用をサポートします。

OAuth 2.0 は、アプリケーション間で標準的なトークンベースの認証および承認を有効にし、中央の承認サーバーを使用してリソースに制限されたアクセス権限を付与するトークンを発行します。

Kafka ブローカーおよびクライアントの両方が OAuth 2.0 を使用するように設定する必要があります。OAuth 2.0 認証を設定した後に OAuth 2.0 承認 を設定できます。

OAuth 2.0 認証は、使用する承認サーバーに関係なく ACL ベースの Kafka 承認 と併用できます。

OAuth 2.0 認証を使用すると、アプリケーションクライアントはアカウントのクレデンシャルを公開せずにアプリケーションサーバー (リソースサーバー と呼ばれる) のリソースにアクセスできます。

アプリケーションクライアントは、アクセストークンを認証の手段として渡します。アプリケーションサーバーはこれを使用して、付与するアクセス権限のレベルを決定することもできます。承認サーバーは、アクセスの付与とアクセスに関する問い合わせを処理します。

AMQ Streams のコンテキストでは以下が行われます。

- Kafka ブローカーは OAuth 2.0 リソースサーバーとして動作します。

- Kafka クライアントは OAuth 2.0 アプリケーションクライアントとして動作します。

Kafka クライアントは Kafka ブローカーに対して認証を行います。ブローカーおよびクライアントは、必要に応じて OAuth 2.0 承認サーバーと通信し、アクセストークンを取得または検証します。

AMQ Streams のデプロイメントでは、OAuth 2.0 インテグレーションは以下を提供します。

- Kafka ブローカーのサーバー側 OAuth 2.0 サポート。

- Kafka MirrorMaker、Kafka Connect、および Kafka Bridge のクライアント側 OAuth 2.0 サポート。

AMQ Streams on RHEL には 2 つの OAuth 2.0 ライブラリーが含まれています。

kafka-oauth-client-

io.strimzi.kafka.oauth.client.JaasClientOauthLoginCallbackHandlerという名前のカスタムログインコールバックハンドラークラスを提供します。OAUTHBEARER認証メカニズムを処理するには、Apache Kafka が提供するOAuthBearerLoginModuleでログインコールバックハンドラーを使用します。 kafka-oauth-common-

kafka-oauth-clientライブラリーに必要な機能の一部を提供するヘルパーライブラリー。

提供されるクライアントライブラリーは、keycloak-core、jackson-databind、および slf4j-api などの追加のサードパーティーライブラリーにも依存します。

Maven プロジェクトを使用してクライアントをパッケージ化し、すべての依存関係ライブラリーが含まれるようにすることが推奨されます。依存関係のライブラリーは、今後のバージョンで変更される可能性があります。

OAuth コールバックハンドラー は Kafka Client Java ライブラリーに提供されるので、Java クライアント用に独自のコールバックハンドラーを作成する必要はありません。アプリケーションクライアントはコールバックハンドラーを使用してアクセストークンを提供できます。Go などの他言語で書かれたクライアントは、カスタムコードを使用して承認サーバーに接続し、アクセストークンを取得する必要があります。

その他のリソース

4.10.1. OAuth 2.0 認証メカニズム

AMQ Streams は、OAuth 2.0 認証で OAUTHBEARER および PLAIN メカニズムをサポートします。どちらのメカニズムも、Kafka クライアントが Kafka ブローカーで認証されたセッションを確立できるようにします。クライアント、承認サーバー、および Kafka ブローカー間の認証フローは、メカニズムごとに異なります。

可能な限り、OAUTHBEARER を使用するようにクライアントを設定することが推奨されます。OAUTHBEARER では、クライアントクレデンシャルは Kafka ブローカーと共有されることがないため、PLAIN よりも高レベルのセキュリティーが提供されます。OAUTHBEARER をサポートしない Kafka クライアントの場合のみ、PLAIN の使用を検討してください。

必要な場合は、同じ OAuth 認証リスナー設定で OAUTHBEARER と PLAIN を一緒に有効にできます。

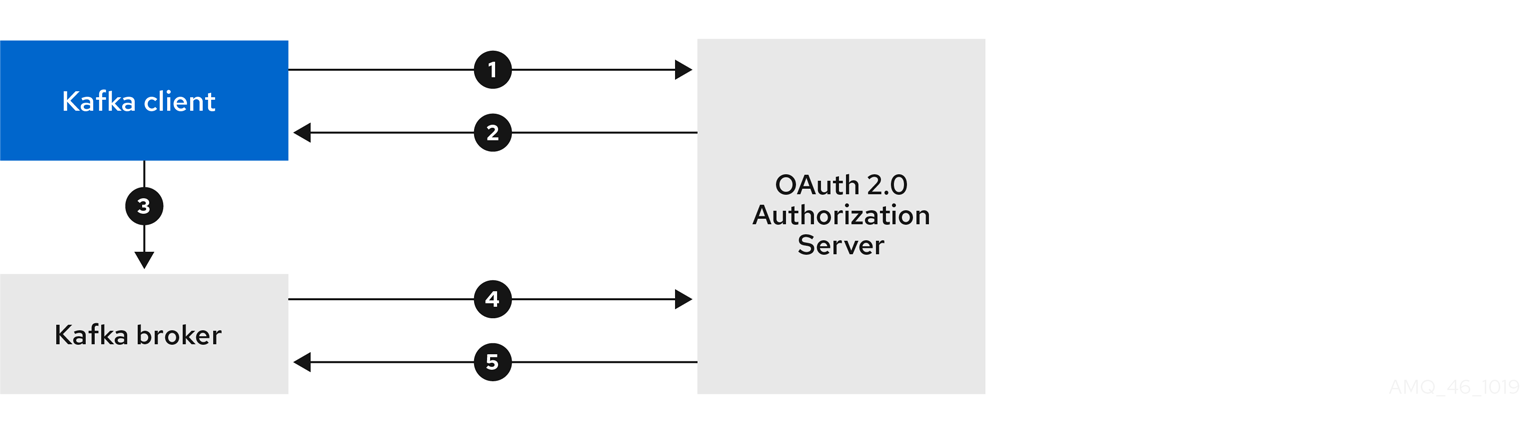

OAUTHBEARER の概要

Kafka は OAUTHBEARER 認証メカニズムをサポートしますが、明示的に設定する必要があります。多くの Kafka クライアントツールでは、プロトコルレベルで OAUTHBEARER の基本サポートを提供するライブラリーを使用します。

OAUTHBEARER を使用する場合、クライアントはクレデンシャルを交換するために Kafka ブローカーでセッションを開始します。ここで、クレデンシャルはコールバックハンドラーによって提供されるベアラートークンの形式を取ります。コールバックを使用して、以下の 3 つの方法のいずれかでトークンの提供を設定できます。

- クライアント ID およびシークレット (OAuth 2.0 クライアントクレデンシャルメカニズム を使用)

- 設定時に手動で取得された有効期限の長いアクセストークン

- 設定時に手動で取得された有効期限の長い更新トークン

OAUTHBEARER を使用するには、Kafka ブローカーの OAuth 認証リスナー設定で sasl.enabled.mechanisms を OAUTHBEARER に設定する必要があります。詳細な設定は、「OAuth 2.0 Kafka ブローカーの設定」を参照してください。

listener.name.client.sasl.enabled.mechanisms=OAUTHBEARER

listener.name.client.sasl.enabled.mechanisms=OAUTHBEAREROAUTHBEARER 認証は、プロトコルレベルで OAUTHBEARER メカニズムをサポートする Kafka クライアントでのみ使用できます。

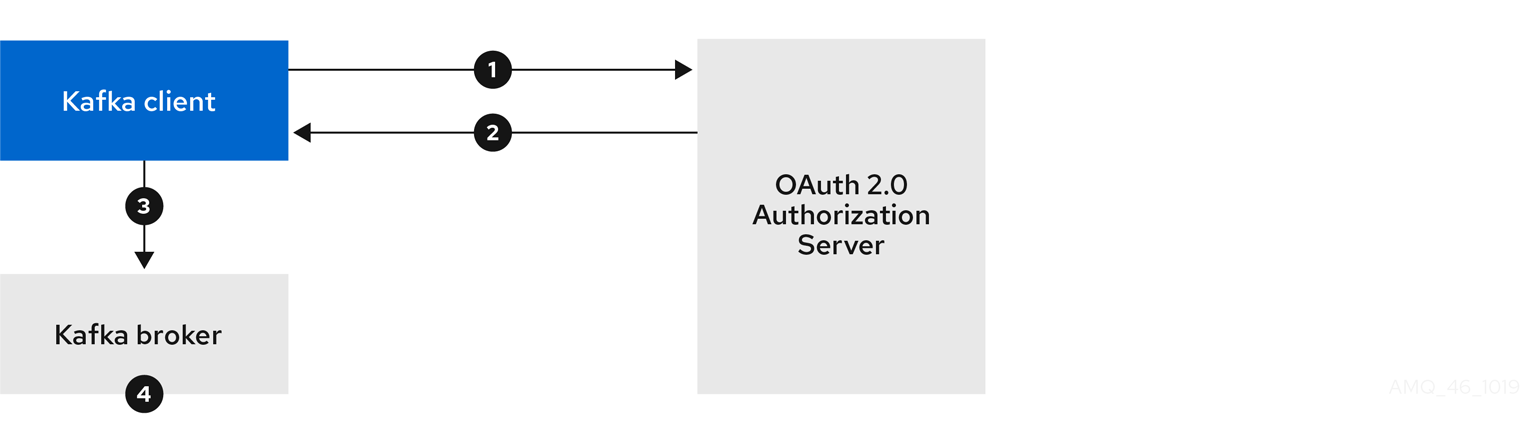

PLAIN の概要

PLAIN は、すべての Kafka クライアントツール (kafkacat などの開発者ツールを含む) によってサポートされる簡易認証メカニズムです。PLAIN を OAuth 2.0 認証と共に使用できるようにするため、AMQ Streams on RHEL にはサーバー側のコールバックが含まれています。PLAIN の AMQ Streams 実装は、OAuth 2.0 over PLAIN と呼ばれます。

OAuth 2.0 over PLAIN では、クライアントクレデンシャルは ZooKeeper に保存されません。代わりに、OAUTHBEARER 認証が使用される場合と同様に、クライアントクレデンシャルは準拠した承認サーバーの背後で一元的に処理されます。

OAuth 2.0 over PLAIN コールバックを併用する場合、以下のいずれかの方法を使用して Kafka クライアントは Kafka ブローカーで認証されます。

- クライアント ID およびシークレット (OAuth 2.0 クライアントクレデンシャルメカニズム を使用)

- 設定時に手動で取得された有効期限の長いアクセストークン

PLAIN 認証を使用し、username および password を提供するように、クライアントを有効にする必要があります。パスワードの最初に $accessToken: が付けられ、その後にアクセストークンの値が続く場合は、Kafka ブローカーはパスワードをアクセストークンとして解釈します。それ以外の場合は、Kafka ブローカーは username をクライアント ID として解釈し、password をクライアントシークレットとして解釈します。

password がアクセストークンとして設定されている場合、username は Kafka ブローカーによってアクセストークンから取得されるプリンシパル名と同じになるように設定される必要があります。このプロセスは、userNameClaim、fallbackUserNameClaim、fallbackUsernamePrefix、または userInfoEndpointUri を使用してユーザー名の抽出を設定する方法によって異なります。また、承認サーバーによっても異なり、特にクライアント ID をアカウント名にマッピングする方法によります。

Kafka ブローカーの OAuth 認証リスナー設定で PLAIN を有効にできます。これを行うには、PLAIN を sasl.enabled.mechanisms の値に追加します。

listener.name.client.sasl.enabled.mechanisms=OAUTHBEARER,PLAIN

listener.name.client.sasl.enabled.mechanisms=OAUTHBEARER,PLAIN詳細な設定は、「OAuth 2.0 Kafka ブローカーの設定」を参照してください。

4.10.1.1. プロパティーまたは変数を使用した OAuth 2.0 の設定

OAuth 2.0 設定は、Java Authentication and Authorization Service (JAAS) プロパティーまたは環境変数を使用して設定できます。

-

JAAS プロパティーは

server.properties設定ファイルで設定され、listener.name.LISTENER-NAME.oauthbearer.sasl.jaas.configプロパティーのキー/値のペアとして渡されます。 環境変数を使用する場合は、

server.propertiesファイルにlistener.name.LISTENER-NAME.oauthbearer.sasl.jaas.configプロパティーを指定する必要がありますが、他の JAAS プロパティーを省略することができます。大文字で始める、または大文字の環境変数命名規則を使用できます。

AMQ Streams OAuth 2.0 ライブラリーは、以下で始まるプロパティーを使用します。

-

oauth.: 認証の設定 -

strimzi.: OAuth 2.0 承認の設定

4.10.2. OAuth 2.0 Kafka ブローカーの設定

OAuth 2.0 認証の Kafka ブローカー設定には、以下が関係します。

- 承認サーバーでの OAuth 2.0 クライアントの作成

- Kafka クラスターでの OAuth 2.0 認証の設定

承認サーバーに関連する Kafka ブローカーおよび Kafka クライアントはどちらも OAuth 2.0 クライアントと見なされます。

4.10.2.1. 承認サーバーの OAuth 2.0 クライアント設定

セッションの開始中に受信されたトークンを検証するように Kafka ブローカーを設定するには、承認サーバーで OAuth 2.0 の クライアント 定義を作成し、以下のクライアントクレデンシャルが有効な状態で 機密情報 として設定することが推奨されます。

-

kafka-brokerのクライアント ID (例) - 認証メカニズムとしてのクライアント ID およびシークレット

承認サーバーのパブリックでないイントロスペクションエンドポイントを使用する場合のみ、クライアント ID およびシークレットを使用する必要があります。高速のローカル JWT トークンの検証と同様に、パブリック承認サーバーのエンドポイントを使用する場合は、通常クレデンシャルは必要ありません。

4.10.2.2. Kafka クラスターでの OAuth 2.0 認証設定

Kafka クラスターで OAuth 2.0 認証を使用するには、Kafka server.properties ファイルで Kafka クラスターの OAuth 認証リスナー設定を有効にします。最小設定が必要です。また、TLS がブローカー間の通信に使用される TLS リスナーを設定することもできます。

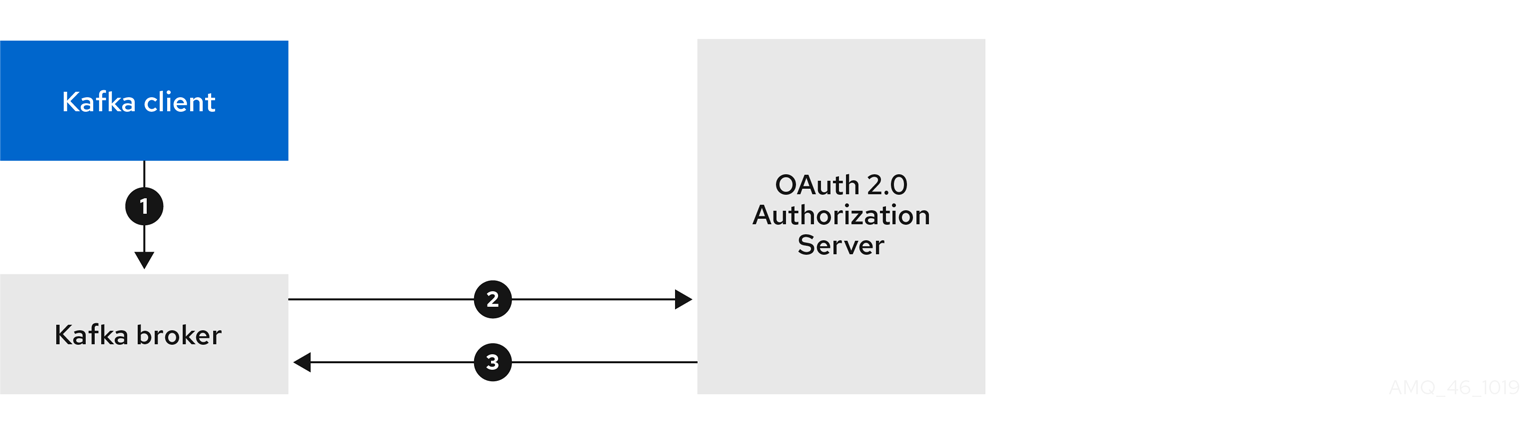

以下の方法のいずれかを使用して、承認サーバーによるトークンの検証用にブローカーを設定できます。

- 高速なローカルトークン検証: 署名付き JWT 形式のアクセストークンと組み合わせた JWKS エンドポイント

- イントロスペクション エンドポイント

OAUTHBEARER または PLAIN 認証、またはその両方を設定できます。

以下の例は、グローバルリスナー設定が適用される最小の設定を示しています。これは、ブローカー間の通信がアプリケーションクライアントと同じリスナーを通過することを意味します。

この例では、sasl.enabled.mechanisms ではなく listener.name.LISTENER-NAME.sasl.enabled.mechanisms を指定する、特定リスナーの OAuth 2.0 設定も示しています。LISTENER-NAME は、リスナーの名前で大文字と小文字の区別はありません。ここではリスナー名を CLIENT としているので、プロパティー名は listener.name.client.sasl.enabled.mechanisms になります。

この例では OAUTHBEARER 認証を使用します。

例: JWKS エンドポイントを使用した OAuth 2.0 認証の最小リスナー設定

- 1

- SASL でのクレデンシャル変換用に OAUTHBEARER メカニズムを有効にします。

- 2

- 接続するクライアントアプリケーション用のリスナーを設定します。システム

hostnameはアドバタイズされたホスト名として使用されます。これは、再接続するためにクライアントが解決する必要があります。この例では、リスナーの名前はCLIENTです。 - 3

- リスナーのチャネルプロトコルを指定します。

SASL_SSLが TLS 用です。暗号化されていない接続 (TLS なし) にはSASL_PLAINTEXTが使用されますが、TCP 接続層での盗聴のリスクがあります。 - 4

- CLIENT リスナーの OAUTHBEARER メカニズムを指定します。クライアント名 (

CLIENT) は通常、listenersプロパティーでは大文字で、listener.nameプロパティー (listener.name.client) では小文字で、listener.name.client.*プロパティーの一部の場合には小文字で指定します。 - 5

- ブローカー間の通信の OAUTHBEARER メカニズムを指定します。

- 6

- ブローカー間の通信のリスナーを指定します。仕様は、有効な設定のために必要です。

- 7

- クライアントリスナーで OAuth 2.0 認証を設定します。

- 8

- クライアントおよびブローカー間の通信の認証設定を設定します。

oauth.client.id、oauth.client.secret、およびauth.token.endpoint.uriプロパティーはブローカー間の設定に関連します。 - 9

- 有効な発行者の URI。この発行者が発行するアクセストークンのみが受け入れられます (例: https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME)。

- 10

- JWKS エンドポイント URL (例: https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME/protocol/openid-connect/certs)。

- 11

- トークンの実際のユーザー名が含まれるトークン要求 (またはキー)。ユーザー名は、ユーザーの識別に使用される principal です。値は、使用される認証フローと承認サーバーによって異なります。

- 12

- すべてのブローカーで同じ Kafka ブローカーのクライアント ID。これは、

kafka-brokerとして承認サーバーに登録されたクライアント です。 - 13

- すべてのブローカーで同じ Kafka ブローカーのシークレット。

- 14

- 承認サーバーへの OAuth 2.0 トークンエンドポイント URL。本番環境では常に HTTPs を使用してください (例: https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME/protocol/openid-connect/token)。

- 15

- ブローカー間の通信に OAuth 2.0 認証を有効にします (この場合にのみ必要)。

- 16

- (任意設定) トークンの有効期限が切れるとセッションの終了を強制し、Kafka の再認証メカニズム も有効にします。指定された値がアクセストークンの有効期限が切れるまでの残り時間未満の場合、クライアントは実際にトークンの有効期限が切れる前に再認証する必要があります。デフォルトでは、アクセストークンの期限が切れてもセッションは期限切れにならず、クライアントは再認証を試行しません。

以下の例は、TLS がブローカー間の通信に使用される TLS リスナーの最小設定を示しています。

例: OAuth 2.0 認証の TLS リスナーの設定

- 1

- ブローカー間の通信とクライアントアプリケーションには、個別の設定が必要です。

- 2

- REPLICATION リスナーが TLS を使用し、CLIENT リスナーが暗号化されていないチャネルを通じて SASL を使用するように設定します。実稼働環境では、クライアントは暗号化されたチャンネル (

SASL_SSL) を使用できます。 - 3

ssl.プロパティーは TLS 設定を定義します。- 4

- 乱数ジェネレーターの実装。これが設定されていない場合、Java プラットフォーム SDK デフォルトが使用されます。

- 5

- ホスト名の検証。空の文字列に設定すると、ホスト名の検証はオフになります。設定されていない場合、デフォルト値は HTTPS で、サーバー証明書のホスト名の検証を強制します。

- 6

- リスナーのキーストアへのパス。

- 7

- リスナーのトラストストアへのパス。

- 8

- (ブローカー間の接続に使用される) TLS 接続の確立時に REPLICATION リスナーのクライアントがクライアント証明書で認証する必要があることを指定します。

- 9

- OAuth 2.0 の CLIENT リスナーを設定します。承認サーバーとの接続は、セキュアな HTTPS 接続を使用する必要があります。

以下の例は、SASL を介したクレデンシャル交換の PLAIN 認証メカニズムを使用した OAuth 2.0 認証の最小設定を示しています。高速なローカルトークン検証が使用されます。

例: PLAIN 認証の最小リスナー設定

- 1

- 接続するクライアントアプリケーション用のリスナー (この例では

CLIENT) を設定します。システムhostnameはアドバタイズされたホスト名として使用されます。これは、再接続するためにクライアントが解決する必要があります。これは唯一の設定済みリスナーであるため、ブローカー間の通信にも使用されます。 - 2

- 暗号化されていないチャネルで SASL を使用するように 例の

CLIENTリスナーを設定します。実稼働環境では、TCP 接続層での盗聴を避けるために、クライアントは暗号化チャンネル (SASL_SSL) を使用する必要があります。 - 3

- SASL を介したクレデンシャル交換の PLAIN 認証メカニズムおよび OAUTHBEARER を有効にします。ブローカー間の通信に必要であるため、OAUTHBEARER も指定されます。Kafka クライアントは、接続に使用するメカニズムを選択できます。

PLAIN 認証は、すべてのプラットフォームのすべてのクライアントでサポートされます。Kafka クライアントは PLAIN メカニズムを有効にし、

usernameおよびpasswordを設定する必要があります。PLAIN を使用すると、OAuth アクセストークンを使用するか、OAuthclientIdおよびsecret(クライアントクレデンシャル) を使用して認証できます。動作は、oauth.token.endpoint.uriが指定されているかどうかによって追加で制御されます。oauth.token.endpoint.uriを指定し、クライアントが文字列$accessToken:で始まるようにpasswordを設定した場合、サーバーはパスワードをアクセストークンとして解釈し、usernameをアカウントのユーザー名として解釈します。それ以外の場合は、usernameはclientIdとして解釈され、passwordはクライアント名のアクセストークンの取得に使用するためにブローカーが使用するクライアントsecretとして解釈されます。oauth.token.endpoint.uriが指定されていない場合、passwordは常にアクセストークンとして解釈され、usernameは常にアカウントユーザー名として解釈されます。これは、トークンから抽出されたプリンシパル ID と一致する必要があります。これは、クライアントが常に独自でアクセストークンを取得する必要があり、clientIdおよびsecretを使用できないため、「no-client-credentials」モードと呼ばれます。 - 4

- ブローカー間の通信の OAUTHBEARER 認証メカニズムを指定します。

- 5

- ブローカー間の通信のリスナー (この例では

CLIENT) を指定します。有効な設定のために必要です。 - 6

- OAUTHBEARER メカニズムのサーバーコールバックハンドラーを設定します。

- 7

- OAUTHBEARER メカニズムを使用して、クライアントおよびブローカー間の通信の認証設定を設定します。

oauth.client.id、oauth.client.secret、およびoauth.token.endpoint.uriプロパティーはブローカー間の設定に関連します。 - 8