自動化実行の設定

Automation Controller の管理、監視、および使用方法について

概要

はじめに

このガイドでは、カスタムスクリプトや管理ジョブなどを使用した Automation Controller の管理を説明します。自動化実行の設定ガイドは、DevOps エンジニアおよび管理者向けに作成され、Automation Controller の使いやすいグラフィカルインターフェイスによる管理が必要なシステムに関する基本的な理解を前提としています。

Red Hat ドキュメントへのフィードバック (英語のみ)

このドキュメントの改善に関するご意見がある場合や、エラーを発見した場合は、https://access.redhat.com からテクニカルサポートに連絡してリクエストを送信してください。

第1章 Automation Controller の起動、停止、および再起動

Automation Controller には、管理者ユーティリティースクリプト automation-controller-service が含まれています。このスクリプトにより、現在の単一の Automation Controller ノード上で実行中のすべての Automation Controller サービスを起動、停止、再起動できます。統合インストールの場合、スクリプトにはメッセージキューコンポーネントとデータベースが含まれます。

外部データベースは、管理者が明示的に管理する必要があります。サービススクリプトは /usr/bin/automation-controller-service にあり、次のコマンドで呼び出すことができます。

root@localhost:~$ automation-controller-service restart

root@localhost:~$ automation-controller-service restart

クラスター化されたインストールの場合、automation-controller-service restart は、再起動するサービスとして PostgreSQL を含みません。これは、PostgreSQL が Automation Controller の外部に存在し、必ずしも再起動する必要がないためです。クラスター環境でサービスを再起動するには、代わりに systemctl restart automation-controller を使用してください。

また、特定の変更を維持するには、ローカルホストインストールの場合とは対照的に、シングルノードではなく各クラスターノードを再起動する必要があります。

クラスター環境の詳細は、クラスタリング セクションを参照してください。

ディストリビューション固有のサービス管理コマンドを使用してサービススクリプトを呼び出すこともできます。ディストリビューションパッケージでは、多くの場合、サービスを管理するための同様のスクリプト (場合によっては init スクリプト) が提供されます。詳細は、お使いのディストリビューション固有のサービス管理システムを参照してください。

コンテナー内で Automation Controller を実行する場合は、automation-controller-service スクリプトを使用しないでください。代わりに、コンテナー環境を使用して Pod を再起動します。

第2章 Automation Controller の設定

ユーザーインターフェイスの Settings メニューを使用して、一部の Automation Controller オプションを設定できます。

Save すると変更が適用されますが、編集ダイアログは終了しません。

Settings ページに戻るには、ナビゲーションパネルから Settings を選択するか、現在のビューの上部にあるブレッドクラムを使用します。

2.1. システム設定の設定

System メニューを使用して、Automation Controller システム設定を定義できます。

手順

- ナビゲーションパネルから、 → → を選択します。System Settings ページが表示されます。

- をクリックします。

以下のオプションを設定できます。

- Base URL of the service: この設定は、有効な URL をサービスにレンダリングする通知などのサービスによって使用されます。

Proxy IP allowed list: サービスがリバースプロキシーまたはロードバランサーの背後にある場合は、この設定を使用して、サービスがカスタム

REMOTE_HOST_HEADERSヘッダーの値を信頼する際に使用するプロキシー IP アドレスを設定します。この設定が空のリスト (デフォルト) の場合、

REMOTE_HOST_HEADERSで指定されたヘッダーは無条件に信頼されます。-

CSRF Trusted Origins List: サービスがリバースプロキシーまたはロードバランサーの背後にある場合、この設定を使用して、サービスがオリジンヘッダーの値を信頼する際に使用する

schema://addressesを設定します。 - Red Hat customer username: このユーザー名は、データを Automation Analytics に送信するために使用されます。

- Red Hat customer password: このパスワードは、データを Automation Analytics に送信するために使用されます。

- Red Hat or Satellite username: このユーザー名は、Automation Analytics にデータを送信するために使用されます。

- Red Hat or Satellite password: このパスワードは、Automation Analytics にデータを送信するために使用されます。

- Global default execution environment: ジョブテンプレートに対して実行環境が設定されていない場合に使用される実行環境。

Custom virtual environment paths: Automation Controller がカスタムの仮想環境を検索するパス。

1 行に 1 つのパスを入力します。

- Last gather date for Automation Analytics: 日付と時刻を設定します。

Automation Analytics Gather Interval データ収集の間隔 (秒単位)。

Gather data for Automation Analytics が false に設定されている場合、この値は無視されます。

- Last cleanup date for HostMetrics: 日付と時刻を設定します。

- Last computing date of HostMetricSummaryMonthly: 日付と時刻を設定します。

-

Remote Host Headers: リモートホスト名または IP を決定するために検索する HTTP ヘッダーとメタキー。リバースプロキシーの背後にある場合は、

HTTP_X_FORWARDED_FORなど、このリストに項目を追加します。詳細は、Red Hat Ansible Automation Platform のプロキシーサポートの設定 を参照してください。 - Automation Analytics upload URL: この値は、設定ファイルに手動で設定されました。この設定は、Automation Analytics のデータ収集用のアップロード URL を設定するために使用されます。

Defines subscription usage model and shows Host Metrics:

以下のオプションを選択できます。

- Enable Activity Stream: アクティビティーストリームのキャプチャーアクティビティーを有効化するように設定します。

- Enable Activity Stream for Inventory Sync: インベントリー同期の実行時に、アクティビティーストリームのアクティビティーのキャプチャーを有効にするように設定します。

- All Users Visible to Organization Admins: 組織管理者が、組織に関連付けられていない場合も含め、すべてのユーザーとチームを表示できるかどうかを制御するように設定します。

Organization Admins Can Manage Users and Teams: 組織管理者がユーザーとチームを作成および管理する権限を持っているかどうかを制御するように設定します。

LDAP または SAML インテグレーションを使用している場合は、この機能を無効化することを推奨します。

- Gather data for Automation Analytics: サービスが自動化のデータを収集し、Automation Analytics に送信できるように設定します。

- をクリックします。

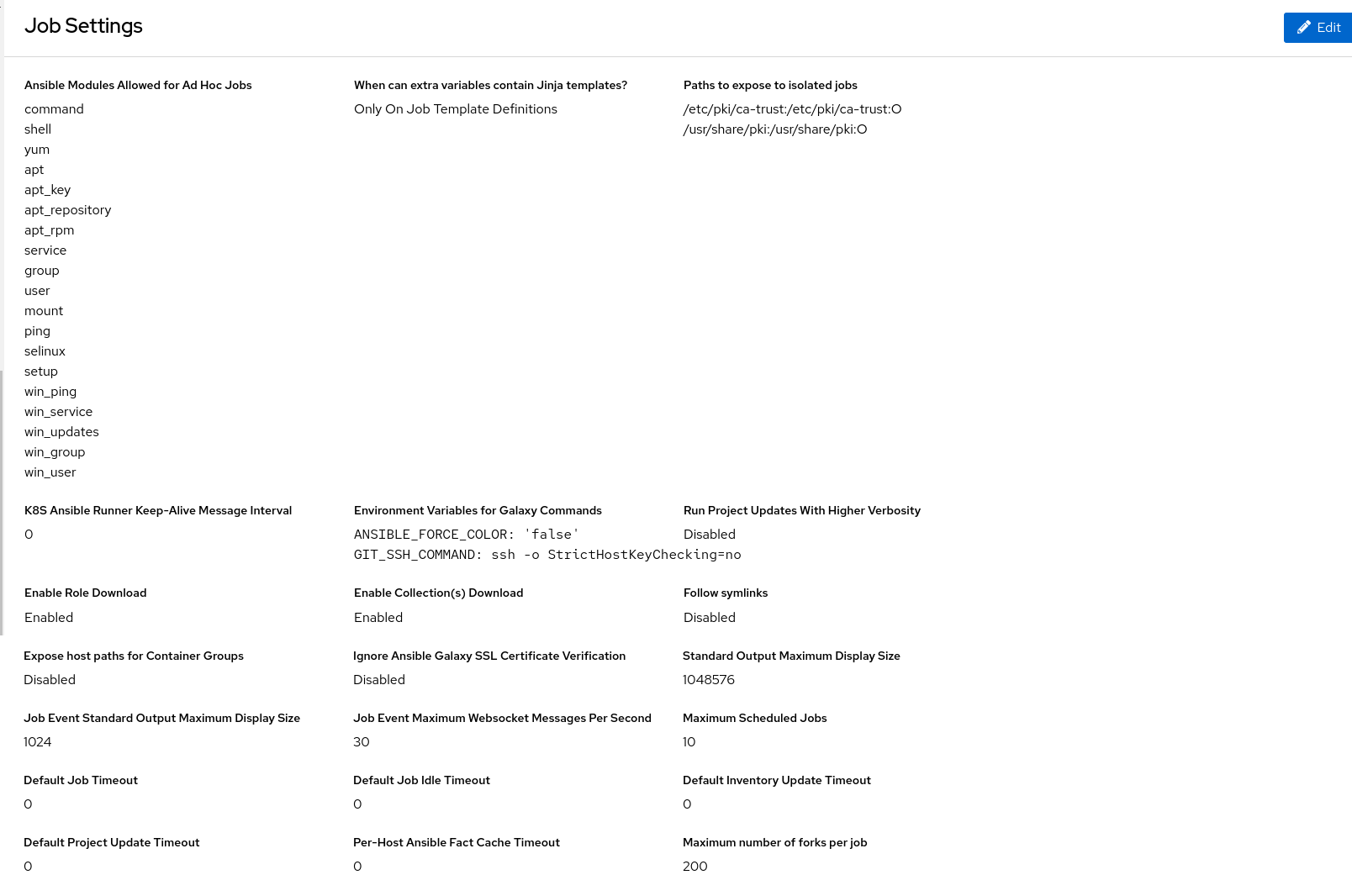

2.2. ジョブの設定

Job オプションを使用して、Automation Controller でジョブの操作を定義できます。

手順

- ナビゲーションパネルから、 → → を選択します。

Job Settings ページで、 をクリックします。

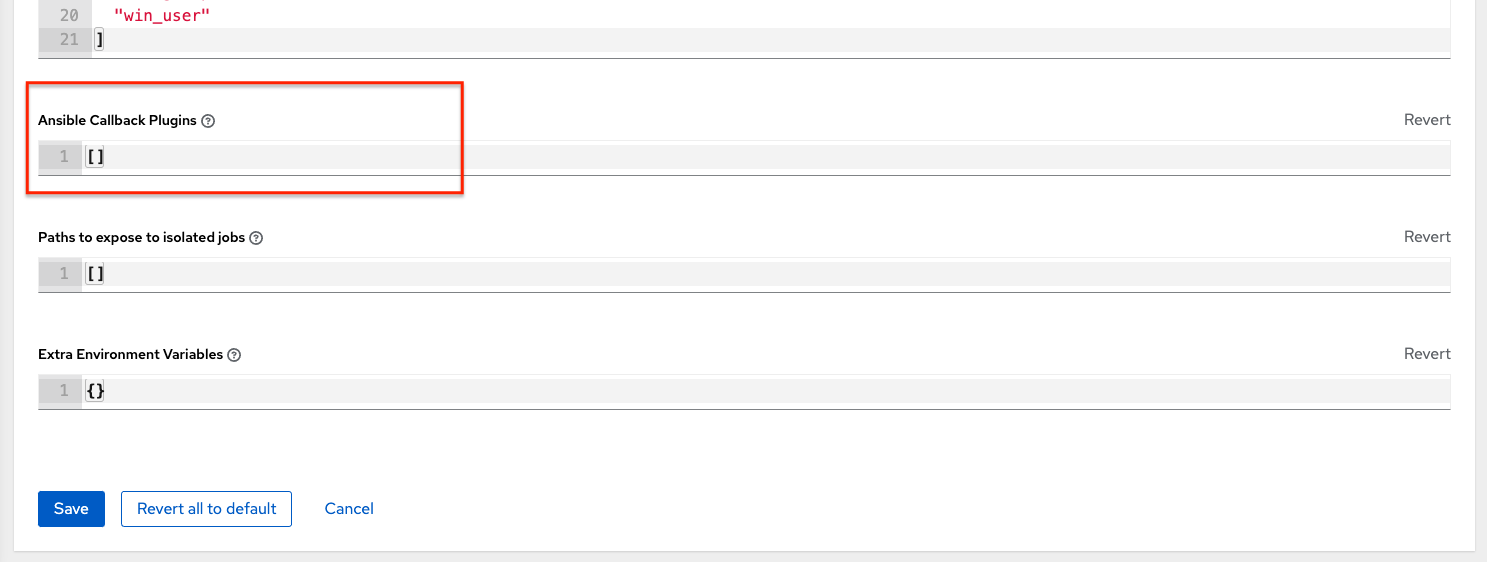

以下のオプションを設定できます。

Ansible Modules Allowed For Ad Hoc Jobs: アドホックジョブで使用できるモジュールのリスト。

サービスが、ジョブの実行および分離用に新規の一時ディレクトリーを作成するディレクトリーです (認証情報ファイルなど)。

When can extra variables contain Jinja templates?: Ansible は、

--extra-varsの Jinja2 テンプレート言語による変数の置換を許可します。これにより、ジョブの起動時に追加の変数を指定できるユーザーが Jinja2 テンプレートを使用して任意の Python を実行できるという潜在的なセキュリティーリスクが生じます。

この値を

templateまたはneverに設定します。Paths to expose to isolated jobs: 分離されたジョブに公開するためのパスのリスト (通常は非表示)。

1 行に 1 つのパスを入力します。特定のファイルへのパスを入力すると、そのファイルを含むディレクトリー全体が実行環境内にマウントされます。

ボリュームは実行ノードからコンテナーにマウントされます。

サポートされるフォーマットは、

HOST-DIR[:CONTAINER-DIR[:OPTIONS]]です。- Extra Environment Variables: Playbook の実行、インベントリーの更新、プロジェクトの更新、通知の送信用に設定された追加の環境変数。

K8S Ansible Runner Keep-Alive Message Interval: コンテナーグループで実行されているジョブにのみ適用されます。

0 以外の場合は、接続を開いたままにするために、指定された秒数ごとにメッセージを送信します。

- Environment Variables for Galaxy Commands: プロジェクトの更新内で ansible-galaxy を呼び出すために設定される追加の環境変数。git ではなく、ansible-galaxy にはプロキシーサーバーを使用する必要がある場合に便利です。

- Standard Output Maximum Display Size: 出力のダウンロードを必要する前に表示する標準出力の最大サイズ (バイト単位)。

-

Job Event Standard Output Maximum Display Size: 単一のジョブまたはアドホックコマンドイベントで表示する標準出力の最大サイズ (バイト単位)。切り捨てられると、stdout は

…で終わります。 Job Event Maximum Websocket Messages Per Second: UI ライブジョブ出力を更新する 1 秒あたりのメッセージの最大数。

値が 0 の場合は制限がないことを意味します。

- Maximum Scheduled Jobs: スケジュールから起動するときに、これ以上作成されなくなるまで実行を待機できる同じジョブテンプレートの最大数。

- Ansible Callback Plugins: ジョブの実行時に使用される追加のコールバックプラグインを検索するためのパスのリスト。

Default Job Timeout: この秒数内に Ansible から出力が検出されない場合、実行は終了します。

アイドルタイムアウトを適用しないことを示すには、値 0 を使用します。

1 行に 1 つのパスを入力します。

Default Job Idle Timeout: この秒数内に Ansible から出力が検出されない場合、実行は終了します。

アイドルタイムアウトを適用しないことを示すには、値 0 を使用します。

Default Inventory Update Timeout: インベントリー更新の実行を許可する最大時間 (秒単位)。

タイムアウトを課さないことを示すには、値 0 を使用します。

個々のインベントリーソースに設定されたタイムアウトは、これをオーバーライドします。

Default Project Update Timeout: プロジェクト更新の実行を許可する最大時間 (秒単位)。

タイムアウトを課さないことを示すには、値 0 を使用します。

個々のプロジェクトに設定されたタイムアウトは、これをオーバーライドします。

Per-Host Ansible Fact Cache Timeout: 保存された Ansible ファクトが最後に変更されてから有効と見なされる最大時間 (秒単位)。

Playbook では、有効で古くないファクトのみにアクセスできます。

これは、データベースからの

ansible_factsの削除には影響しません。タイムアウトを課さないことを示すには、値 0 を使用します。

Maximum number of forks per job: この数を超えるフォークを含むジョブテンプレートを保存すると、エラーが発生します。

0 に設定すると、制限は適用されません。

- Job execution path: Operator ベースのインストールでのみ使用できます。

Container Run Options: Operator ベースのインストールでのみ使用できます。

Podman 実行に渡すオプションのリストの例:

['--network', 'slirp4netns:enable_ipv6=true', '--log-level', 'debug']以下のオプションを設定できます。

-

Run Project Updates With Higher Verbosity: プロジェクト更新に使用される

project_update.ymlの Playbook 実行に CLI-vvvフラグを追加する場合に選択します。 -

Enable Role Download: SCM プロジェクトの

requirements.ymlファイルからロールを動的にダウンロードできるようにする場合に選択します。 -

Enable Collection(s) Download: SCM プロジェクトの

requirements.ymlファイルからコレクションを動的にダウンロードできるようにする場合に選択します。 Follow symlinks: Playbook をスキャンするときにシンボリックリンクに従う場合に選択します。

これを

Trueに設定すると、リンクが自身の親ディレクトリーを指している場合、無限再帰が発生する可能性があることに注意してください。Expose host paths for Container Groups: コンテナーグループによって作成された Pod のパスを hostPath を通じて公開する場合に選択します。

HostPath ボリュームには多くのセキュリティーリスクが伴うため、可能な場合は HostPath の使用を避けることがベストプラクティスとなります。

Ignore Ansible Galaxy SSL Certificate Verification:

trueに設定すると、どの Galaxy サーバーからコンテンツをインストールするときにも、証明書の検証は行われません。追加情報が必要な場合、対象のフィールドの横にあるツールチップアイコン

をクリックします。

をクリックします。

Galaxy 設定に関する詳細は、自動化実行の使用 の Ansible Galaxy サポート セクションを参照してください。

注記すべてのタイムアウト値は秒単位です。

- をクリックして設定を適用します。

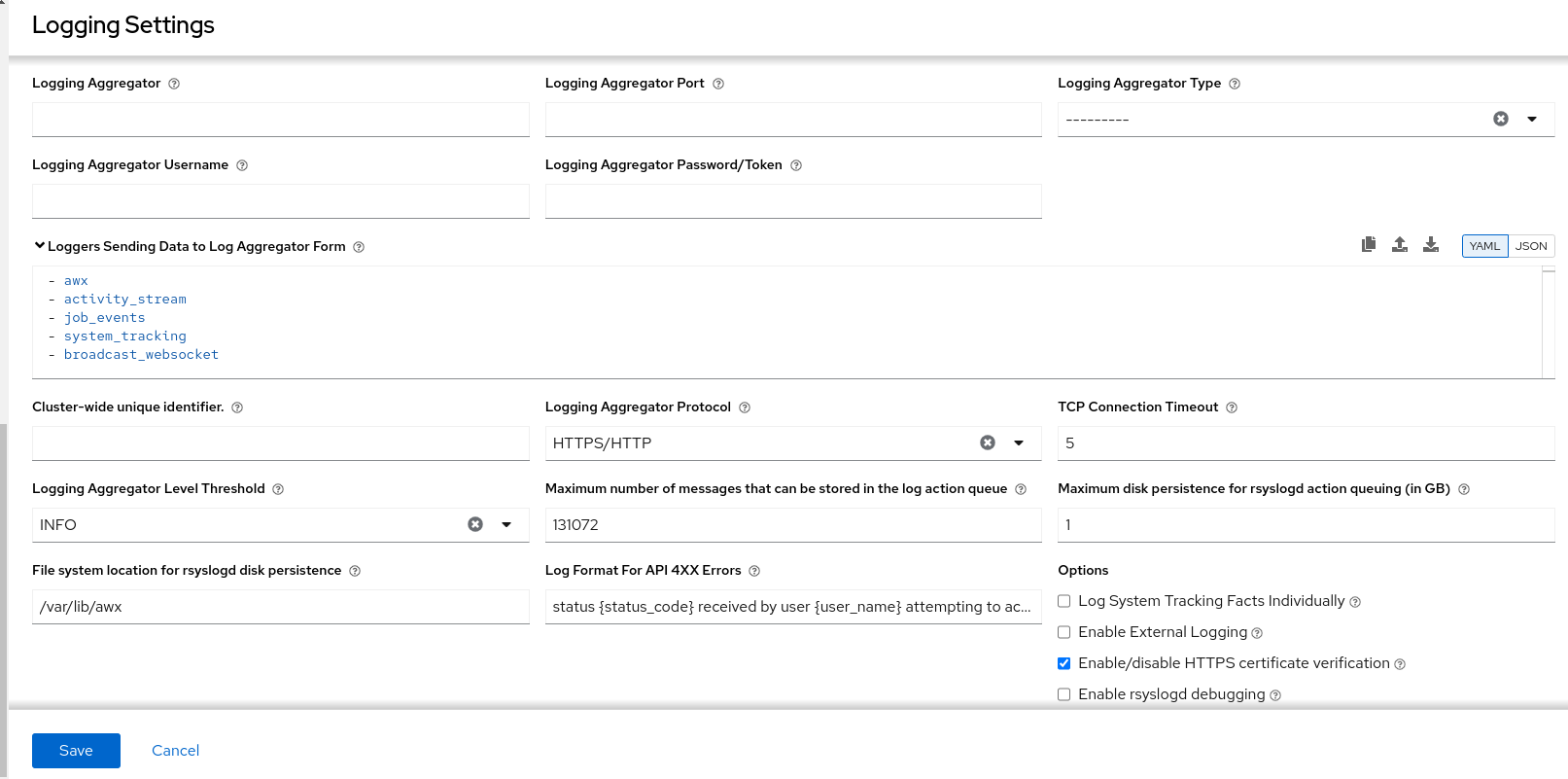

2.3. ロギングとアグリゲーションの設定

これらの設定の詳細は、ロギングのセットアップ を参照してください。

2.4. Automation Analytics の設定

ライセンスの初回インポート時に、Automation Analytics (Ansible Automation Platform サブスクリプションに含まれるクラウドサービス) を強化するデータの収集が自動的にオプトインされます。

前提条件

- console.redhat.com で Automation Analytics Viewer ロールを使用して作成したサービスアカウント。詳細は、サービスアカウントの作成 を参照してください。

手順

- ナビゲーションパネルから、 → → を選択します。

- をクリックします。

- Red Hat Client ID for Analytics という名前のフィールドに、サブスクリプションとコンテンツ情報を取得するためのサービスアカウントを作成したときに受け取ったクライアント ID を入力します。

- Red Hat Client Secret for Analytics という名前のフィールドに、Automation Analytics にデータを送信するためのサービスアカウントを作成したときに受け取ったクライアントシークレットを入力します。

- Options リストで、Gather data for Automation Analytics チェックボックスをオンにします。

- をクリックします。

検証

サービスアカウントを設定した後、テストジョブを実行して、すべてが正しく設定されていることを確認します。

- ナビゲーションパネルから → を選択してジョブを起動します。

- console.redhat.com で分析 を確認して、データが送信されていることを確認します。

2.5. Automation Controller の追加設定

Automation Controller の動作に影響を与える可能性のある追加の詳細設定が存在します。当該設定を Automation Controller UI で行うことはできません。

従来の仮想マシンベースのデプロイメントの場合、/etc/tower/conf.d/custom.py にファイルを作成することで、これらの設定を Automation Controller に提供できます。ファイルベースの設定を通じて Automation Controller に設定を提供する場合、設定ファイルはすべてのコントロールプレーンノードに存在する必要があります。これらのノードは、インストーラーインベントリーの automationcontroller グループに属するハイブリッドまたはコントロールタイプのノードすべてを含みます。

これらの設定を有効にするには、設定ファイルを有する各ノードで、automation-controller-service restart を使用してサービスを再起動します。このファイルで指定した設定が Automation Controller UI にも表示される場合、UI では "Read only" とマークされます。

コンテナーベースのインストールの場合、Automation Controller の変数 の controller_extra_settings を使用してください。コンテナー化されたバージョンは custom.py をサポートしていません。

第3章 Automation Controller のパフォーマンスチューニング

Automation Controller をチューニングしてパフォーマンスとスケーラビリティを最適化します。ワークロードを計画するときは、パフォーマンスとスケーリングのニーズを特定し、制限に合わせて調整し、デプロイメントを監視してください。

Automation Controller は、次のようなチューニング可能なコンポーネントが多数含まれる分散システムです。

- ジョブのスケジューリングを担当するタスクシステム

- ジョブの制御と出力の処理を担当するコントロールプレーン

- ジョブが実行される実行プレーン

- API の提供を担当する Web サーバー

- WebSocket 接続とデータを提供およびブロードキャストする WebSocket システム

- 多くのコンポーネントで使用されるデータベース

3.1. Automation Controller の WebSocket 設定

Automation Controller を設定して、WebSocket 設定を nginx またはロードバランサーの設定と合わせることができます。

Automation Controller ノードは、Websocket を介して相互接続され、Websocket が発行するすべてのメッセージをシステム全体に分散します。この設定セットアップにより、任意のブラウザークライアント Websocket が、任意の Automation Controller ノードで実行されている可能性がある任意のジョブにサブスクライブできるようになります。WebSocket クライアントは特定の Automation Controller ノードにルーティングされません。代わりに、すべての Automation Controller ノードが任意の Websocket 要求を処理できます。各 Automation Controller ノードは、すべてのクライアントに宛てたすべての Websocket メッセージを把握しておく必要があります。

WebSocket は、すべての Automation Controller ノードの /etc/tower/conf.d/websocket_config.py で設定できます。変更はサービスの再起動後に有効になります。

Automation Controller は、データベース内のインスタンスレコードを介して、他の Automation Controller ノードの検出を自動的に処理します。

Automation Controller ノードは、(オープンインターネットではなく) プライベートで信頼できるサブネットを介して Websocket トラフィックをブロードキャストするように設計されています。そのため、Websocket ブロードキャストの HTTPS をオフにすると、Ansible Playbook の標準出力 (stdout) の大部分で構成される Websocket トラフィックは、Automation Controller ノード間で暗号化されずに送信されます。

3.1.1. 他の Automation Controller ノードの自動検出の設定

WebSocket 接続を設定して、Automation Controller がデータベースのインスタンスレコードを使用して他の Automation Controller ノードの検出を自動的に処理できるようにします。

Automation Controller の WebSocket のポートとプロトコルの情報を編集し、WebSocket 接続を確立するときに証明書を検証するかどうかを

TrueまたはFalseで確認します。BROADCAST_WEBSOCKET_PROTOCOL = 'http' BROADCAST_WEBSOCKET_PORT = 80 BROADCAST_WEBSOCKET_VERIFY_CERT = False

BROADCAST_WEBSOCKET_PROTOCOL = 'http' BROADCAST_WEBSOCKET_PORT = 80 BROADCAST_WEBSOCKET_VERIFY_CERT = FalseCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを使用して Automation Controller を再起動します。

automation-controller-service restart

$ automation-controller-service restartCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.2. Automation Controller をデプロイするための容量のプランニング

Automation Controller の容量のプランニングでは、計画されたワークロードを実行する容量を確保できるように、デプロイメントのスケールと特性について計画します。容量のプランニングには次のフェーズが含まれます。

- ワークロードの特徴付け

- さまざまなノードタイプの機能の確認

- ワークロードの要件に基づくデプロイメントのプランニング

3.2.1. ワークロードの特徴

デプロイメントを計画する前に、サポートするワークロードを確立します。Automation Controller ワークロードを特徴付けるために、次の要素を考慮してください。

- 管理対象ホスト

- ホストごとの 1 時間あたりのタスク数

- サポートする同時実行ジョブの最大数

- ジョブに設定するフォークの最大数。フォークによって、ジョブがいくつのホストで同時に動作するかが決まります。

- 1 秒あたりの API 要求の最大数

- デプロイするノードのサイズ (CPU/メモリー/ディスク)

3.2.2. Automation Controller のノードのタイプ

Automation Controller デプロイメントでは、4 種類のノードを設定できます。

- コントロールノード

- ハイブリッドノード

- 実行ノード

- ホップノード

ただし、Operator ベースの環境には、ハイブリッドノードやコントロールノードはありません。Kubernetes クラスター上で実行されるコンテナーを構成するコンテナーグループはあります。それがコントロールプレーンを構成します。このコントロールプレーンは、Red Hat Ansible Automation Platform がデプロイされている Kubernetes クラスターに対してローカルです。

3.2.2.1. コントロールノードをスケーリングする利点

コントロールノードとハイブリッドノードは、制御容量を提供します。これらのノードは、ジョブを開始し、データベースへの出力を処理する機能を提供します。すべてのジョブにはコントロールノードが割り当てられます。デフォルト設定では、各ジョブを制御するには 1 の容量単位が必要です。たとえば、100 の容量単位を持つコントロールノードは、最大 100 個のジョブを制御できます。

より多くのリソースを備えた大規模な仮想マシンをデプロイして、コントロールノードを垂直スケーリングすると、コントロールプレーンの次の機能が向上します。

- コントロールノードが制御タスクを実行できるジョブの数。この数を増やすには、より多くの CPU とメモリーが必要です。

- コントロールノードが同時に処理できるジョブイベントの数。

CPU とメモリーを同じ比率でスケーリングすることを推奨します (例: 1 CPU: 4 GB RAM)。メモリー消費量が多い場合でも、インスタンスの CPU を増やすことで負荷が軽減されることがよくあります。コントロールノードが消費するメモリーの大部分は、メモリーベースのキューに格納されている未処理のイベントによるものです。

コントロールノードを垂直スケーリングしても、Web 要求を処理するワーカーの数は自動的に増加しません。

垂直スケーリングの代わりに、より多くのコントロールノードをデプロイして水平スケーリングを行うこともできます。これにより、ロードバランサーをプロビジョニングしてノード間で要求を分散する場合、制御タスクをより多くのノードに分散できるほか、Web トラフィックもより多くのノードに分散できます。より多くのコントロールノードをデプロイする水平スケーリングのほうが、多くの点で望ましい場合があります。コントロールノードがダウンしたり、通常よりも高い負荷がかかったりした場合に、冗長性が向上し、ワークロードが分離されるためです。

3.2.2.2. 実行ノードをスケーリングする利点

実行ノードとハイブリッドノードは実行容量を提供します。ジョブが消費する容量は、ジョブテンプレートに設定されているフォークの数とインベントリー内のホストの数のいずれか少ない方に、メインの Ansible プロセスを考慮した 1 容量単位を加えたものと等しくなります。たとえば、デフォルトのフォーク値が 5 のジョブテンプレートが 50 台のホストを持つインベントリーで動作している場合、このジョブテンプレートは、割り当てられている実行ノードから 6 容量単位を消費します。

より多くのリソースを備えたより大規模な仮想マシンをデプロイすることで実行ノードを垂直スケーリングすると、ジョブ実行のためのフォークが増加します。これにより、インスタンスで実行できる同時実行ジョブの数が増加します。

一般に、CPU とメモリーを同じ比率でスケーリングすることを推奨します。コントロールノードやハイブリッドノードと同様に、各実行ノードには容量調整があります。容量調整を使用して、Automation Controller が作成する容量消費の推定値に合わせて実際の使用量を調整できます。デフォルトでは、すべてのノードがその範囲の上限に設定されます。実際の監視データによりノードが過剰に使用されていると判明した場合、容量調整を減らすことで、実際の使用量と一致させることができます。

実行ノードを垂直スケーリングする代わりに、より多くの仮想マシンを実行ノードとしてデプロイして、実行プレーンを水平スケーリングすることもできます。水平スケーリングによりワークロードをさらに分離できるため、異なるインスタンスを異なるインスタンスグループに割り当てることができます。これらのインスタンスグループは、組織、インベントリー、またはジョブテンプレートに割り当てることができます。たとえば、特定のインベントリーに対してジョブを実行する場合にのみ使用できるインスタンスグループを設定できます。この場合、実行プレーンを水平スケーリングすることで、優先度の低いジョブが優先度の高いジョブをブロックしないようにすることができます。

3.2.2.3. ホップノードをスケーリングする利点

ホップノードが使用するメモリーと CPU は非常に少ないため、これらのノードを垂直スケーリングしても容量には影響しません。多くの実行ノードとコントロールプレーンの間の唯一の接続として機能するホップノードについては、ネットワーク帯域幅を監視してください。帯域幅の使用量が飽和している場合は、ネットワークの変更を検討してください。

ホップノードを追加して水平スケーリングすると、1 つのホップノードがダウンしても冗長性が提供され、コントロールプレーンと実行ノードの間でトラフィックを流し続けることができます。

3.2.2.4. 制御容量と実行容量の比率

デフォルト設定を前提とすると、従来の仮想マシンのデプロイメントでは、制御容量と実行容量の最大推奨比率は 1:5 です。この比率により、利用可能なすべての実行容量でジョブを実行して出力を処理するための、十分な制御容量が確保されます。実行容量に対して制御容量が少ないと、実行容量を使用する十分な数のジョブを起動できなくなります。

この比率を 1:1 に近づけることが推奨される場合があります。たとえば、ジョブが高レベルのジョブイベントを生成する場合、制御容量に対して実行容量を減らすと、出力を処理するためにコントロールノードに掛かる負荷が軽減されます。

3.3. 容量プランニングの演習例

サポートするワークロード容量を決定したら、ワークロードの要件に基づいてデプロイメントを計画する必要があります。デプロイメントに役立つように、次のプランニング演習を確認してください。

この例では、クラスターは次の容量をサポートする必要があります。

- 300 台の管理対象ホスト

- ホストごとに 1 時間あたり 1,000 タスク、またはホストごとに 1 分あたり 16 タスク

- 10 個の同時ジョブ

- Playbook でフォークが 5 に設定されている。これはデフォルトになります。

- 1 MB の平均イベントサイズ

仮想マシンには、4 つの CPU と 16 GB の RAM、および 3000 IOPS のディスクが搭載されています。

3.3.1. ワークロード要件の例

この容量プランニングの演習例では、次のワークロード要件を使用します。

実行容量

10 個の同時実行ジョブを実行するには、少なくとも 60 単位の実行容量が必要です。

- これは、(10 個のジョブ * 5 つのフォーク) + (10 個のジョブ * ジョブの 1 基本タスクインパクト) = 60 実行容量という式を使用して計算します。

制御容量

- 10 個の同時実行ジョブを制御するには、少なくとも 10 ユニットの制御容量が必要です。

300 台の管理対象ホストで、ホストごとに 1 時間あたり 1,000 個のタスクをサポートするために必要な 1 時間あたりのイベント数を計算するには、次の式を使用します。

- 1 時間あたり 1000 個のタスク * 300 台の管理対象ホスト = 1 時間あたり少なくとも 300,000 個のイベント

- ジョブが生成するイベントの数を正確に確認するには、ジョブを実行する必要があります。これは、イベントの数が特定のタスクと詳細度に依存するためです。たとえば、“Hello World” を出力するデバッグタスクは、1 つのホストで詳細度 1 のジョブイベントを 6 つ生成します。詳細度を 3 にすると、1 つのホストで 34 個のジョブイベントを生成します。したがって、タスクは少なくとも 6 つのイベントを生成すると推定する必要があります。これにより、1 時間あたり 3,000,000 個近くのイベント、つまり 1 秒あたり約 833 個のイベントが生成されることになります。

必要な実行ノードとコントロールノードの数の決定

必要な実行ノードとコントロールノードの数を決定するには、次の表に示す実験結果を参照してください。この表は、1 つのコントロールノードに対して同サイズの実行ノードが 5 つある場合に確認されたイベント処理速度を示しています (API 容量の列)。ジョブテンプレートのデフォルトの “フォーク” 設定は 5 です。そのため、このデフォルト値を使用すると制御容量と実行容量の比率が前述の 1:5 になり、ディスパッチ可能な最大数のジョブをコントロールノードが実行ノードにディスパッチした場合に、CPU/RAM が等しい 5 つの実行ノードが容量を 100% 使用することになります。

| ノード | API 容量 | デフォルトの実行容量 | デフォルトの制御容量 | 容量使用率 100% での平均イベント処理速度 | 容量使用率 50% での平均イベント処理速度 | 容量使用率 40% での平均イベント処理速度 |

|---|---|---|---|---|---|---|

| 4 CPU (2.5 Ghz)、16 GB RAM のコントロールノード、最大 3000 IOPS のディスク | 1 秒あたり約 10 リクエスト | 該当なし | 137 ジョブ | 1 秒あたり 1100 | 1 秒あたり 1400 | 1 秒あたり 1630 |

| 4 CPU (2.5 Ghz)、16 GB RAM の実行ノード、最大 3000 IOPS のディスク | 該当なし | 137 | 該当なし | 該当なし | 該当なし | 該当なし |

| 4 CPU (2.5 Ghz)、16 GB RAM のデータベースノード、最大 3000 IOPS のディスク | 該当なし | 該当なし | 該当なし | 該当なし | 該当なし | 該当なし |

ジョブの制御はコントロールノード上のジョブイベント処理と競合するため、制御容量をオーバープロビジョニングすると処理時間が短縮される可能性があります。処理時間が長い場合、ジョブの実行から API または UI で出力を表示できるようになるまでに遅延が発生する可能性があります。

この例において、300 台の管理対象ホストのワークロードがあり、ホストごとに 1 時間あたり 1000 個のタスクを実行し、Playbook でフォークを 5 に設定した 10 個の同時実行ジョブがあり、平均イベントサイズが 1 MB の場合、次の手順を使用します。

- 4 つの 2.5 Ghz の CPU、16 GB の RAM、および約 3000 IOPS のディスクを備えた 1 つの実行ノード、1 つのコントロールノード、1 つのデータベースノードをデプロイします。

- ジョブテンプレートで、フォーク設定をデフォルトの 5 に維持します。

- コントロールノードの UI のインスタンスビューで容量変更機能を使用して、容量を最低値を 16 まで減らし、イベント処理用に確保するコントロールノードの容量を増やします。

高レベルの API インタラクションを伴うワークロードの詳細は、Scaling Automation Controller for API Driven Workloads を参照してください。インスタンスによる容量の管理に関する詳細は、インスタンスによる容量の管理 を参照してください。Operator ベースのデプロイメントの詳細は、Operator 環境に関する Red Hat Ansible Automation Platform の考慮事項 を参照してください。

3.4. Automation Controller のパフォーマンスのトラブルシューティング

要求のタイムアウト (504 または 503 エラー) が多く発生するか、一般に API レイテンシーが増大します。UI では、クライアントはログインに時間がかかり、ページがロードされるまでの待機時間が長くなります。どのシステムが原因であると考えられますか?

- これらの問題がログイン時にのみ発生し、外部認証を使用する場合は、外部認証プロバイダーのインテグレーションに問題がある可能性があるため、Red Hat サポートにお問い合わせください。

- タイムアウトや API レイテンシーの増大に関するその他の問題は、Web サーバーのチューニング を参照してください。

ジョブ出力がロードされるまでの待機時間が長くなります。

- ジョブ出力は、ansible-playbook を実際に実行する実行ノードから、関連するコントロールノードにストリーミングされます。次に、コールバックレシーバーがこのデータをシリアライズし、データベースに書き込みます。確認およびチューニングする関連設定は、ジョブイベント処理を管理するための設定 および Automation Controller の PostgreSQL データベースの設定およびメンテナンス を参照してください。

- 一般に、この症状を解決するには、コントロールノードの CPU とメモリーの使用状況を確認することが重要です。CPU またはメモリーの使用率が非常に高い場合は、より多くの仮想マシンをコントロールノードとしてデプロイし、コントロールプレーンを水平スケーリングすることで作業をさらに分散させるか、コントロールノードが一度に管理するジョブの数を変更します。詳細は、コントロールノードと実行ノードの容量設定 を参照してください。

- プラットフォームにプルされていない実行環境を使用する初期ジョブ実行では、ジョブ出力遅延が発生する可能性があります。ジョブの実行が完了すると出力が表示されます。

Automation Controller が同時に実行できるジョブの数を増やすにはどうすればよいですか?

ジョブが “保留” 状態のままになる要因は次のとおりです。

- “依存関係” が完了するのを待機している: これには、“起動時の更新” 動作が有効になっている場合のプロジェクトの更新とインベントリーの更新が含まれます。

- ジョブテンプレートの "allow_simultaneous" 設定: 同じジョブテンプレートの複数のジョブが “pending” 状態の場合は、ジョブテンプレートの "allow_simultaneous" 設定 (UI の "Concurrent Jobs" チェックボックス) を確認します。これが有効になっていない場合、ジョブテンプレートのジョブは一度に 1 つしか実行できません。

- ジョブテンプレートの “forks” 値: デフォルト値は 5 です。ジョブの実行に必要な容量は、おおよそフォーク値と等しくなります (多少のオーバーヘッドは考慮されます)。フォーク値を非常に大きな数に設定すると、それを実行できるノードが制限されます。

- 制御容量または実行容量の不足: /api/v2/metrics で利用可能なアプリケーションメトリクスの “awx_instance_remaining_capacity” メトリクスを確認します。メトリクスを確認する方法の詳細は、Automation Controller アプリケーションを監視するためのメトリクス を参照してください。必要な数のジョブを処理するようにデプロイメントを計画する方法は、Automation Controller をデプロイするための容量のプランニング を参照してください。

ローカルマシンよりも Automation Controller の方がジョブの実行に時間がかかります。

- オーバーヘッドは多少増大すると想定されています。これは、Automation Controller が別のノードにジョブをディスパッチしている場合があるためです。この場合、Automation Controller はコンテナーを起動し、そこで ansible-playbook を実行し、すべての出力をシリアライズしてデータベースに書き込みます。

- 起動時のプロジェクト更新と、起動時のインベントリー更新の動作により、ジョブの開始時に遅延が増大する可能性があります。

- プロジェクトはコントロールノードで更新されて実行ノードに転送されるため、プロジェクトのサイズがジョブの開始にかかる時間に影響する可能性があります。内部クラスタールーティングは、ネットワークのパフォーマンスに影響を与える可能性があります。詳細は、内部クラスタールーティング を参照してください。

- コンテナーのプル設定は、ジョブの開始時間に影響を与える可能性があります。実行環境は、ジョブの実行に使用するコンテナーです。コンテナーのプル設定は、“Always”、“Never”、または “If not present” に設定できます。コンテナーが常にプルされている場合、遅延が発生する可能性があります。

- すべてのクラスターノード (実行ノード、コントロールノード、データベースノードを含む) が、最小要件の IOPS を満たすストレージを備えたインスタンスにデプロイされていることを確認してください。これは、Automation Controller が Ansible を実行してイベントデータをキャッシュする方法では、大量のディスク I/O が生じるためです。詳細は、システム要件 を参照してください。

データベースストレージが増加し続けます。

- Automation Controller には、“Cleanup Job Details” というタイトルの管理ジョブがあります。デフォルトでは、120 日分のデータを保持し、週に 1 回実行するように設定されています。データベース内のデータ量を減らすために、保持期間を短縮できます。詳細は、以前のアクティビティーストリームデータの削除 を参照してください。

- クリーンアップジョブを実行すると、データベース内のデータが削除されます。ただし、データベースはいずれかの時点で、ストレージを解放するバキューム操作を実行する必要があります。データベースのバキューム処理の詳細は、Automation Controller の PostgreSQL データベースの設定およびメンテナンス を参照してください。

3.5. Automation Controller を監視するためのメトリクス

Automation Controller ホストをシステムレベルとアプリケーションレベルで監視します。

システムレベルの監視では、次の情報が含まれます。

- ディスク I/O

- RAM 使用率

- CPU 使用率

- ネットワークトラフィック

アプリケーションレベルのメトリクスは、アプリケーションがシステムについて把握しているデータを提供します。このデータには次の情報が含まれます。

- 特定のインスタンスで実行されているジョブの数

- クラスター内のインスタンスに関する容量情報

- 存在するインベントリーの数

- インベントリーに含まれるホストの数

システムおよびアプリケーションのメトリクスを使用すると、サービスが低下したときにアプリケーションで何が起きていたのかを特定するのに役立ちます。Automation Controller の経時的なパフォーマンスに関する情報は、問題の診断や、将来の拡張に備えた容量プランニングを行うときに役立ちます。

3.5.1. Automation Controller アプリケーションを監視するためのメトリクス

アプリケーションレベルの監視のために、Automation Controller は、API エンドポイント /api/v2/metrics で Prometheus スタイルのメトリクスを提供します。これらのメトリクスを使用して、ジョブの出力処理やジョブのスケジューリングなどに関する、ジョブのステータスとサブシステムのパフォーマンスに関する集計データを監視します。

メトリクスエンドポイントには、各メトリクスの説明が含まれます。パフォーマンスに関する特に重要なメトリクスの例は以下のとおりです。

awx_status_total- 各ステータスにあるジョブの現在の合計です。他のイベントをシステム内のアクティビティーに関連付けるのに役立ちます。

- エラーまたは失敗したジョブの増加を監視できます。

awx_instance_remaining_capacity

- 追加のジョブを実行するために残っている容量です。

callback_receiver_event_processing_avg_seconds- 通称 “ジョブイベントラグ” です。

- Ansible でタスクが発生してからユーザーがそれを確認できるようになるまでのラグタイムの移動平均です。これは、コールバックレシーバーがイベントの処理でどれだけ遅延しているかを示します。この数が非常に大きい場合、ユーザーはコントロールプレーンをスケールアップするか、容量調整機能を使用してコントロールノードが制御するジョブの数を減らすことを検討できます。

callback_receiver_events_insert_db- ノードによって挿入されたイベントのカウンターです。特定の期間におけるジョブイベント挿入率を計算するために使用できます。

callback_receiver_events_queue_size_redis- コールバックレシーバーがイベントの処理でどれだけ遅延しているかを示すインジケーターです。値が高すぎると、Redis によってコントロールノードのメモリー不足 (OOM) が発生する可能性があります。

3.5.2. システムレベルの監視

インスタンスの容量管理では、ホストの実際のリソース使用量がイントロスペクトされないため、クラスターホストの CPU とメモリーの使用状況を監視することが重要です。自動化ジョブのリソースへの影響は、Playbook が実行する内容によって異なります。たとえば、多くのクラウドモジュールやネットワークモジュールは、Ansible Playbook を実行する実行ノードでほとんどの処理を行います。Automation Controller への影響は、“yum” のようなネイティブモジュールを実行している場合とは大きく異なります。このようなネイティブモジュールの場合、作業はターゲットホストで実行され、タスクの実行中、実行ノードは多くの時間を結果の待機に費やします。

CPU またはメモリーの使用率が非常に高い場合は、Automation Controller で、関連するインスタンスの容量調整を下げることを検討してください (インスタンスの詳細ページで行うことができます)。これにより、当該インスタンスで実行または制御するジョブの数が制限されます。

ディスク I/O とシステムの使用状況を監視します。Automation Controller ノードが Ansible を実行し、出力をファイルシステムにキャッシュして、最終的にデータベースに保存する方法では、多くのディスク読み取りと書き込みが発生します。ディスクのパフォーマンス低下を早期に特定すると、ユーザーエクスペリエンスの低下やシステムのパフォーマンス低下を防ぐのに役立ちます。

3.6. Automation Controller の PostgreSQL データベースの設定およびメンテナンス

Automation Controller のパフォーマンスを向上させるために、データベースで次の設定パラメーターを設定できます。

メンテナンス

VACUUM タスクと ANALYZE タスクは、パフォーマンスに影響を与える可能性がある重要なメンテナンス作業です。通常の PostgreSQL 操作では、更新によって削除または不要になったタプルはテーブルから物理的に削除されません。これらは、VACUUM が完了するまで残ります。したがって、頻繁に更新されるテーブルでは特に、定期的に VACUUM を実行する必要があります。ANALYZE は、データベース内のテーブルの内容に関する統計情報を収集し、結果を pg_statistic システムカタログに保存します。その後、クエリープランナーはこれらの統計情報を使用して、クエリーの最も効率的な実行計画を決定します。自動バキュームに関する PostgreSQL 設定パラメーターは、VACUUM コマンドおよび ANALYZE コマンドの実行を自動化します。自動バキュームは true に設定することを推奨します。ただし、データベースにアイドル時間がまったくない場合、自動バキュームは実行されません。自動バキュームによってデータベースディスクの領域が十分にクリーンアップされていないことが確認された場合、特定のメンテナンス期間中に特定のバキュームタスクをスケジューリングすることで解決する場合があります。

設定パラメーター

PostgreSQL サーバーのパフォーマンスを向上させるには、データベースメモリーを管理する次の Grand Unified Configuration (GUC) パラメーターを設定します。これらのパラメーターは、データベースサーバーの設定を管理する postgresql.conf ファイルの $PDATA ディレクトリー内にあります。

-

shared_buffers: データをキャッシュするためにサーバーに割り当てるメモリーの量を決定します。このパラメーターのデフォルト値は 128 MB です。この値を変更する場合は、マシンの合計 RAM の 15% - 25% に設定する必要があります。

OpenSSL 3.2 に対して Postgres をコンパイルすると、システムでリグレッションが発生し、起動時にユーザーのパラメーターが削除されます。これを修正するには、open_get_data の代わりに BIO_get_app_data 呼び出しを使用します。このような変更は管理者のみが行うことができますが、PostgreSQL データベースに接続しているすべてのユーザーに影響します。OpenSSL パッチを適用せずにシステムを更新する場合は影響しないため、対処する必要はありません。

shared_buffers の値を変更した後は、データベースサーバーを再起動する必要があります。

OpenSSL 3.2 に対して Postgres をコンパイルすると、システムでリグレッションが発生し、起動時にユーザーのパラメーターが削除されます。これを修正するには、open_get_data の代わりに BIO_get_app_data 呼び出しを使用します。この変更を行えるのは管理者だけです。ただし、この変更は、PostgreSQL データベースに接続しているすべてのユーザーに影響します。

OpenSSL パッチを適用せずにシステムを更新した場合、影響を受けないため、対策を講じる必要はありません。

work_mem: ディスクスワッピングの前に内部ソート操作とハッシュテーブルで使用されるメモリーの量を指定します。ソート操作は、order by、distinct、および merge join 操作に使用されます。ハッシュテーブルは、hash joins と hash-based アグリゲーションで使用されます。このパラメーターのデフォルト値は 4 MB です。work_memパラメーターに正しい値を設定すると、ディスクスワッピングが減少し、検索速度が向上します。-

次の式を使用して、データベースサーバーの

work_memパラメーターの最適な値を計算します。

-

次の式を使用して、データベースサーバーの

Total RAM * 0.25 / max_connections

Total RAM * 0.25 / max_connections

work_mem に大きな値を設定すると、データベースに対して開いている接続が多すぎる場合に、PostgreSQL サーバーがメモリー不足 (OOM) になる可能性があります。

-

max_connections: データベースサーバーへの同時接続の最大数を指定します。 -

maintenance_work_mem: vacuum、create index、および alter table add foreign key 操作などのメンテナンス操作で使用するメモリーの最大量を指定します。このパラメーターのデフォルト値は 64 MB です。このパラメーターの値を計算するには、次の式を使用します。

Total RAM * 0.05

Total RAM * 0.05

バキューム処理のパフォーマンスを向上させるには、maintenance_work_mem を work_mem よりも高く設定します。

関連情報

3.6.1. Automation Controller 設定ファイル内のプレーンテキストパスワードの暗号化

Automation Controller 設定ファイルに保存されるパスワードは、プレーンテキストで保存されます。/etc/tower/conf.d/ ディレクトリーへのアクセス権を持つユーザーは、データベースへのアクセスに使用されるパスワードを表示できます。ディレクトリーへのアクセスは権限によって制御されるため、ディレクトリーは保護されていますが、セキュリティーに関する調査結果によっては、この保護は不十分であると考えられています。解決策は、パスワードを個別に暗号化することです。

3.6.1.1. PostgreSQL パスワードハッシュの作成

Automation Controller 設定ファイル内のプレーンテキストパスワードを置き換えるハッシュ値を指定します。

手順

Automation Controller ノードで、次のコマンドを実行します。

awx-manage shell_plus

# awx-manage shell_plusCopy to Clipboard Copied! Toggle word wrap Toggle overflow 続いて、python プロンプトから以下を実行します。

>>> from awx.main.utils import encrypt_value, get_encryption_key \ >>> postgres_secret = encrypt_value('$POSTGRES_PASS') \ >>> print(postgres_secret)>>> from awx.main.utils import encrypt_value, get_encryption_key \ >>> postgres_secret = encrypt_value('$POSTGRES_PASS') \ >>> print(postgres_secret)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記$POSTGRES_PASS変数を、暗号化する実際のプレーンテキストのパスワードに置き換えます。出力は以下のようになります。

$encrypted$UTF8$AESCBC$Z0FBQUFBQmtLdGNRWXFjZGtkV1ZBR3hkNGVVbFFIU3hhY21UT081eXFkR09aUWZLcG9TSmpndmZYQXFyRHVFQ3ZYSE15OUFuM1RHZHBqTFU3S0MyNEo2Y2JWUURSYktsdmc9PQ==

$encrypted$UTF8$AESCBC$Z0FBQUFBQmtLdGNRWXFjZGtkV1ZBR3hkNGVVbFFIU3hhY21UT081eXFkR09aUWZLcG9TSmpndmZYQXFyRHVFQ3ZYSE15OUFuM1RHZHBqTFU3S0MyNEo2Y2JWUURSYktsdmc9PQ==Copy to Clipboard Copied! Toggle word wrap Toggle overflow これらのハッシュの完全な値をコピーして保存します。

次の例に示すように、ハッシュ値は

$encrypted$で始まり、単なる文字列ではありません。$encrypted$AESCBC$Z0FBQUFBQmNONU9BbGQ1VjJyNDJRVTRKaFRIR09Ib2U5TGdaYVRfcXFXRjlmdmpZNjdoZVpEZ21QRWViMmNDOGJaM0dPeHN2b194NUxvQ1M5X3dSc1gxQ29TdDBKRkljWHc9PQ==

$encrypted$AESCBC$Z0FBQUFBQmNONU9BbGQ1VjJyNDJRVTRKaFRIR09Ib2U5TGdaYVRfcXFXRjlmdmpZNjdoZVpEZ21QRWViMmNDOGJaM0dPeHN2b194NUxvQ1M5X3dSc1gxQ29TdDBKRkljWHc9PQ==Copy to Clipboard Copied! Toggle word wrap Toggle overflow $*_PASS値は、インベントリーファイル内ですでにプレーンテキストになっていることに注意してください。

3.6.1.2. Postgres パスワードの暗号化

次の手順では、プレーンテキストのパスワードを暗号化された値に置き換えます。クラスター内の各ノードで次の手順を実行します。

手順

以下を使用して

/etc/tower/conf.d/postgres.pyを編集します。vim /etc/tower/conf.d/postgres.py

$ vim /etc/tower/conf.d/postgres.pyCopy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルの先頭に次の行を追加します。

from awx.main.utils import decrypt_value, get_encryption_key

from awx.main.utils import decrypt_value, get_encryption_keyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 'PASSWORD': の後にリストされているパスワード値を削除し、次の行に置き換えて、指定された

$encrytpted..の値を独自のハッシュ値に置き換えます。decrypt_value(get_encryption_key('value'),'$encrypted$AESCBC$Z0FBQUFBQmNONU9BbGQ1VjJyNDJRVTRKaFRIR09Ib2U5TGdaYVRfcXFXRjlmdmpZNjdoZVpEZ21QRWViMmNDOGJaM0dPeHN2b194NUxvQ1M5X3dSc1gxQ29TdDBKRkljWHc9PQ=='),decrypt_value(get_encryption_key('value'),'$encrypted$AESCBC$Z0FBQUFBQmNONU9BbGQ1VjJyNDJRVTRKaFRIR09Ib2U5TGdaYVRfcXFXRjlmdmpZNjdoZVpEZ21QRWViMmNDOGJaM0dPeHN2b194NUxvQ1M5X3dSc1gxQ29TdDBKRkljWHc9PQ=='),Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記このステップのハッシュ値は、

postgres_secretの出力値です。完全な

postgres.pyは次のようになります。Ansible Automation platform controller database settings. from awx.main.utils import decrypt_value, get_encryption_key DATABASES = { 'default': { 'ATOMIC_REQUESTS': True, 'ENGINE': 'django.db.backends.postgresql', 'NAME': 'awx', 'USER': 'awx', 'PASSWORD': decrypt_value(get_encryption_key('value'),'$encrypted$AESCBC$Z0FBQUFBQmNONU9BbGQ1VjJyNDJRVTRKaFRIR09Ib2U5TGdaYVRfcXFXRjlmdmpZNjdoZVpEZ21QRWViMmNDOGJaM0dPeHN2b194NUxvQ1M5X3dSc1gxQ29TdDBKRkljWHc9PQ=='), 'HOST': '127.0.0.1', 'PORT': 5432, } }# Ansible Automation platform controller database settings. from awx.main.utils import decrypt_value, get_encryption_key DATABASES = { 'default': { 'ATOMIC_REQUESTS': True, 'ENGINE': 'django.db.backends.postgresql', 'NAME': 'awx', 'USER': 'awx', 'PASSWORD': decrypt_value(get_encryption_key('value'),'$encrypted$AESCBC$Z0FBQUFBQmNONU9BbGQ1VjJyNDJRVTRKaFRIR09Ib2U5TGdaYVRfcXFXRjlmdmpZNjdoZVpEZ21QRWViMmNDOGJaM0dPeHN2b194NUxvQ1M5X3dSc1gxQ29TdDBKRkljWHc9PQ=='), 'HOST': '127.0.0.1', 'PORT': 5432, } }Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.7. Automation Controller のチューニング

UI、API、ファイル設定を使用して、次のような多くの Automation Controller 設定を指定できます。

- Automation Controller UI のライブイベント

- ジョブイベントの処理とスケジューリング

- コントロールノードおよび実行ノードの容量

- インスタンスとコンテナーグループの容量

- 内部クラスタールーティング

- Web サーバーのチューニング

3.7.1. Automation Controller UI でのライブイベントの管理

イベントは、ジョブにサブスクライブされた UI クライアントが存在するノードすべてに送信されます。このタスクはコストが高く、クラスターが生成するイベントの数が増加し、コントロールノードの数が増加するにつれて、さらにコストが高くなります。これは、特定のジョブにサブスクライブされたクライアントの数に関係なく、すべてのイベントがすべてのノードにブロードキャストされるためです。

UI にライブイベントを表示するオーバーヘッドを削減するために、管理者は次のいずれかを選択できます。

- ライブストリーミングイベントを無効にします。

- UI でイベントを縮小したり非表示にしたりする前に、1 秒あたりに表示されるイベントの数を減らします。

イベントのライブストリーミングを無効にすると、イベントは、ジョブの出力詳細ページのハードリフレッシュ時にのみロードされます。1 秒あたりに表示されるイベントの数を減らすと、ライブイベントを表示するオーバーヘッドは限定されますが、ハードリフレッシュを行わなくても UI でライブ更新が提供されます。

3.7.1.1. ライブストリーミングイベントの無効化

手順

次のいずれかの方法を使用して、ライブストリーミングイベントを無効にします。

-

API で、

UI_LIVE_UPDATES_ENABLEDを False に設定します。 - Automation Controller に移動します。Miscellaneous System Settings ウィンドウを開きます。Enable Activity Stream のトグルを Off に設定します。

-

API で、

3.7.1.2. イベントのレートとサイズを変更する設定

イベントのサイズが原因でイベントのライブストリーミングを無効にできない場合は、UI に表示されるイベントの数を減らします。次の設定を使用して、表示されるイベントの数を管理できます。

UI または API で編集できる設定:

-

EVENT_STDOUT_MAX_BYTES_DISPLAY: 表示するstdoutの最大量 (バイト単位で測定)。これにより、UI に表示されるサイズが縮小されます。 -

MAX_WEBSOCKET_EVENT_RATE: 1 秒あたりにクライアントに送信するイベントの数。

ファイルベースの設定を使用して利用可能な設定:

-

MAX_UI_JOB_EVENTS: 表示するイベントの数。この設定により、リスト内の残りのイベントが非表示になります。 -

MAX_EVENT_RES_DATA: Ansible コールバックイベントの "res" データ構造の最大サイズ。"res" はモジュールの完全な「結果」です。Ansible コールバックイベントの最大サイズに達すると、残りの出力は切り捨てられます。デフォルト値は 700000 バイトです。 -

LOCAL_STDOUT_EXPIRE_TIME:stdoutファイルの有効期限が切れてローカルで削除されるまでの時間。

3.7.2. ジョブイベント処理を管理するための設定

コールバックレシーバーはジョブのすべての出力を処理し、この出力をジョブイベントとして Automation Controller データベースに書き込みます。コールバックレシーバーには、イベントをバッチで処理するワーカーのプールがあります。ワーカーの数は、インスタンスで使用可能な CPU の数に応じて自動的に増加します。

管理者は、JOB_EVENT_WORKERS 設定を使用してコールバックレシーバーワーカーの数をオーバーライドできます。CPU ごとに複数のワーカーを設定することはできません。また、少なくとも 1 つのワーカーが必要です。値が大きいほど、Automation Controller にイベントがストリーミングされる際に、Redis キューをクリアするのに利用できるワーカーが増えますが、Web サーバーなどの他のプロセスと CPU 秒数で競合する可能性があります。また、より多くのデータベース接続 (ワーカーあたり 1 つ) を使用するほか、各ワーカーがコミットするイベントのバッチサイズが小さくなる可能性があります。

各ワーカーにより、バッチで書き込むイベントのバッファーが増大します。バッチを書き込む前に待機するデフォルトの時間は 1 秒です。これは、JOB_EVENT_BUFFER_SECONDS 設定によって制御されます。ワーカーがバッチ間で待機する時間を増やすと、バッチサイズが大きくなる可能性があります。

3.7.3. コントロールノードと実行ノードの容量設定

次の設定は、クラスターの容量計算に影響します。次のファイルベースの設定を使用して、すべてのコントロールノードでこれらを同じ値に設定します。

-

AWX_CONTROL_NODE_TASK_IMPACT: ジョブの制御の影響を設定します。コントロールプレーンが望ましい使用量を超えて CPU またはメモリーを使用している場合に、この設定を使用して、コントロールプレーンが同時に実行可能なジョブの数を制御できます。 -

SYSTEM_TASK_FORKS_CPUおよびSYSTEM_TASK_FORKS_MEM: Ansible の各フォークが消費すると推定されるリソースの数を制御します。デフォルトでは、Ansible の 1 フォークは、0.25 の CPU と 100 MB のメモリーを使用すると推定されます。

3.7.4. インスタンスグループとコンテナーグループの容量設定

インスタンスグループで使用できる max_concurrent_jobs および max_forks 設定を使用して、インスタンスグループまたはコンテナーグループ全体で消費できるジョブとフォークの数を制限します。

-

コンテナーグループで必要な

max_concurrent_jobsを計算するには、そのコンテナーグループのpod_spec設定を考慮してください。pod_specでは、自動化ジョブ Pod のリソース要求と制限を確認できます。次の式を使用して、必要な同時実行ジョブの最大数を計算します。

((number of worker nodes in kubernetes cluster) * (CPU available on each worker)) / (CPU request on pod_spec) = maximum number of concurrent jobs

((number of worker nodes in kubernetes cluster) * (CPU available on each worker)) / (CPU request on pod_spec) = maximum number of concurrent jobsたとえば、

pod_specで、Pod が 250 mcpu を要求することが示され、Kubernetes クラスターに 2 CPU を備えたワーカーノードが 1 つある場合、開始する必要があるジョブの最大数は 8 です。-

ジョブのフォークのメモリー消費も考慮することができます。次の式を使用して、

max_forksの適切な設定を計算します。

-

ジョブのフォークのメモリー消費も考慮することができます。次の式を使用して、

((number of worker nodes in kubernetes cluster) * (memory available on each worker)) / (memory request on pod_spec) = maximum number of forks

((number of worker nodes in kubernetes cluster) * (memory available on each worker)) / (memory request on pod_spec) = maximum number of forksたとえば、8 GB のメモリーを持つワーカーノードが 1 つある場合、実行する

max forksは 81 であることがわかります。この場合、1 つのフォークを持つ 39 個のジョブを実行するか (タスクインパクトは常にフォーク + 1 です)、またはフォークが 39 に設定されたジョブを 2 つ実行できます。-

他のビジネス要件では、

max_forksまたはmax_concurrent_jobsを使用して、コンテナーグループ内で起動するジョブの数を制限することが望ましい可能性があります。

-

他のビジネス要件では、

3.7.5. ジョブのスケジューリングの設定

タスクマネージャーは、スケジュールする必要があるタスクを定期的に収集して、どのインスタンスに容量があり、タスクを実行可能かを判断します。タスクマネージャーのワークフローは、以下の通りです。

- 制御インスタンスと実行インスタンスを見つけて割り当てます。

- ジョブのステータスを更新して、待機中にします。

-

pg_notifyを通じてコントロールノードにメッセージを送り、ディスパッチャーがタスクを取得して実行を開始できるようにします。

スケジューリングタスクが TASK_MANAGER_TIMEOUT 秒 (デフォルトは 300 秒) 以内に完了しない場合、タスクは早期に終了します。タイムアウトの問題は通常、保留中のジョブが多数存在する場合に発生します。

タスクマネージャーが 1 回の実行で処理できる作業量を制限する方法の 1 つに、START_TASK_LIMIT 設定があります。これにより、1 回の実行で開始できるジョブの数が制限されます。デフォルトは 100 ジョブです。さらに保留中のジョブがある場合は、新しいスケジューラータスクが直後に実行されるようにスケジュールされます。全体的なスループット向上のために、ジョブの起動から開始までのレイテンシーが潜在的に増大しても構わない場合は、START_TASK_LIMIT を引き上げることを検討できます。タスクマネージャーの個々の実行にかかる時間を確認するには、/api/v2/metrics で入手可能な Prometheus メトリクス task_manager__schedule_seconds を使用します。

タスクマネージャーによって実行の開始が選択されたジョブは、タスクマネージャープロセスが終了して変更がコミットされるまで実行されません。TASK_MANAGER_TIMEOUT 設定は、タスクマネージャーが変更をコミットするまでの 1 回の実行時間を決定します。タスクマネージャーは、タイムアウトに達すると進捗状況をコミットしようとします。タスクは、猶予期間 (TASK_MANAGER_TIMEOUT_GRACE_PERIOD により決定) が経過するまでは強制終了されません。

3.7.6. 内部クラスタールーティング

Automation Controller クラスターホストは、クラスター内のネットワークを介して通信します。従来の仮想マシンインストーラーのインベントリーファイルでは、クラスターノードへのルートを複数指定でき、それらはさまざまな方法で使用されます。

例:

[automationcontroller] controller1 ansible_user=ec2-user ansible_host=10.10.12.11 node_type=hybrid routable_hostname=somehost.somecompany.org

[automationcontroller]

controller1 ansible_user=ec2-user ansible_host=10.10.12.11 node_type=hybrid routable_hostname=somehost.somecompany.org-

controller1は、Automation Controller ホストのインベントリーホスト名です。インベントリーホスト名は、アプリケーションではインスタンスホスト名として表示されるものです。これは、バックアップ/復元方法を使用して異なる IP アドレスを持つ新しいホストのセットにクラスターを復元する、障害復旧シナリオに備える際に役立ちます。この場合、これらのインベントリーホスト名を IP アドレスにマッピングするエントリーを/etc/hostsに含めることができます。そして、内部 IP アドレスを使用して、パブリック DNS 名の解決に関する DNS の問題を軽減できます。 -

ansible_host=10.10.12.11は、インストーラーがホスト (この場合は内部 IP アドレス) に到達する方法を示します。これはインストーラー以外では使用されません。 -

routable_hostname=somehost.somecompany.orgは、receptor メッシュ上でこのノードに接続するピアにとって解決可能なホスト名を示します。複数のネットワークをまたぐ可能性があるため、ホスト名は、receptor ピアで解決可能な IP アドレスにマッピングされるものを使用しています。

3.7.7. Web サーバーのチューニング

コントロールノードとハイブリッドノードはそれぞれ、Automation Controller の UI と API を提供します。WSGI トラフィックは、ローカルソケット上の uwsgi Web サーバーによって処理されます。ASGI トラフィックは、Daphne によって処理されます。NGINX はポート 443 でリッスンし、必要に応じてトラフィックをプロキシー処理します。

Automation Controller の Web サービスをスケーリングするには、次のベストプラクティスに従ってください。

- 複数のコントロールノードをデプロイし、ロードバランサーを使用して Web 要求を複数のサーバーに分散させます。

- Automation Controller ごとの最大接続数を 100 に設定します。

クライアント側で Automation Controller の Web サービスを最適化するには、次のガイドラインに従ってください。

- API を使用してインベントリーホストを個別に作成するのではなく、動的インベントリーソースを使用するようにユーザーに指示します。

- ジョブのステータスをポーリングする代わりに Webhook 通知を使用します。

- ホストの作成とジョブの起動に Bulk API を使用して、要求をバッチ処理します。

- トークン認証を使用します。多くの要求を迅速に行う必要がある自動化クライアントの場合、トークンを使用することがベストプラクティスです。これは、ユーザーのタイプによっては、Basic 認証を使用すると追加のオーバーヘッドが発生する可能性があるためです。

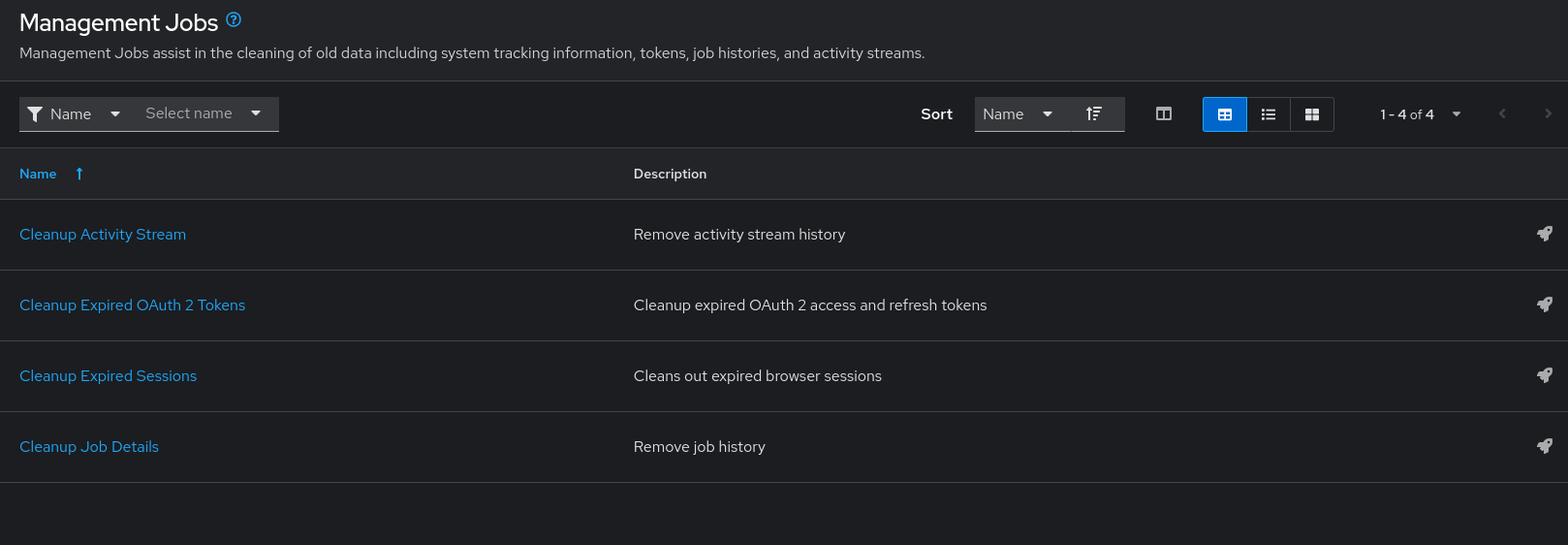

第4章 管理ジョブ

Management Jobs は、システム追跡情報、トークン、ジョブ履歴、アクティビティーストリームなどの古いデータを Automation Controller から消去するのに役立ちます。

これは、特定の保持ポリシーがある場合、または Automation Controller データベースで使用されるストレージを減らす必要がある場合に使用できます。

ナビゲーションパネルから → → を選択します。

次のジョブタイプをスケジュールして起動できます。

- Cleanup Activity Stream: 指定した日数より前のアクティビティーストリーム履歴を削除します。

- Cleanup Expired Sessions: データベースから期限切れのブラウザーセッションを削除します。

- Cleanup Job Details: 指定した日数より前のジョブ履歴を削除します。

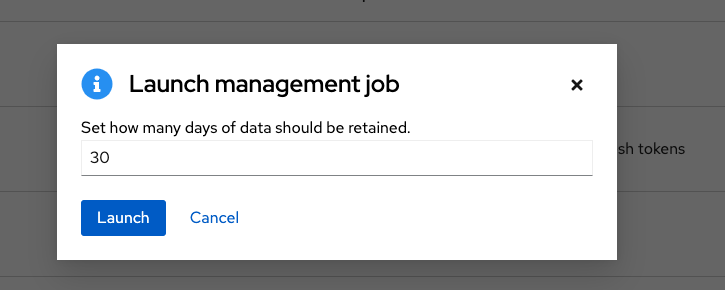

4.1. 以前のアクティビティーストリームデータの削除

以前のアクティビティーストリームデータを削除するには、Cleanup Activity Stream の横にある起動アイコン (

![]() ) をクリックします。

) をクリックします。

データの保存日数を入力し、 をクリックします。

4.1.1. 削除のスケジューリング

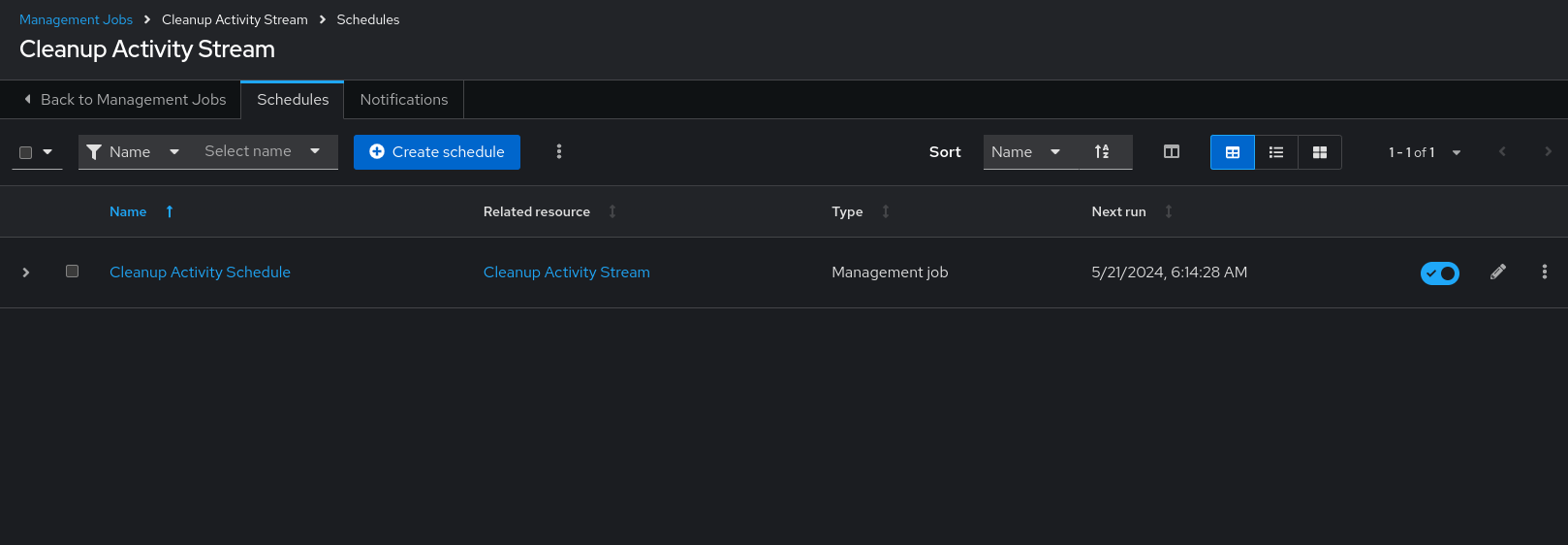

削除対象としてマークされたデータを削除するスケジュールを確認または設定するには、次の手順を使用します。

手順

特定のクリーンアップジョブの場合、Schedules タブをクリックします。

- ジョブ名 (この例では Cleanup Activity Schedule) をクリックして、スケジュール設定を確認します。

をクリックして変更します。 をクリックして、この管理ジョブの新規スケジュールを作成することもできます。

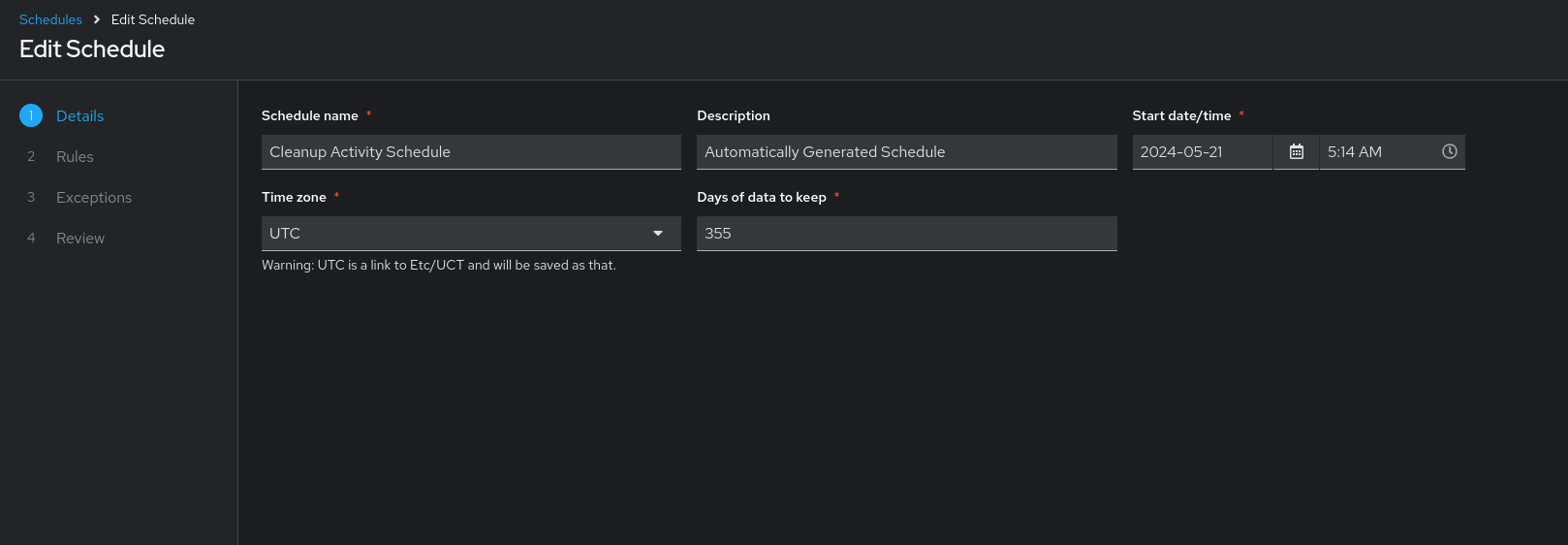

以下のフィールドに適切な情報を入力して、Next をクリックします。

- Schedule name 必須

- Start date/time 必須

- Time zone 入力した Start time はこのタイムゾーンの時間になります。

- Repeat frequency: 更新頻度を変更すると、適切なオプションが表示されます。例外を指定して、対象外とするデータを指定することもできます。

- Days of data to keep 必須 - 保持するデータの量を指定します。

Details タブでは、選択した Local Time Zone でのスケジュールの詳細と、スケジュール実行のリストを表示します。

ジョブは UTC でスケジュールされます。特定の時間に実行される繰り返しのジョブは、夏時間への切り替えまたは夏時間からの切り替えが発生すると、ローカルタイムゾーンに合わせて移動できます。

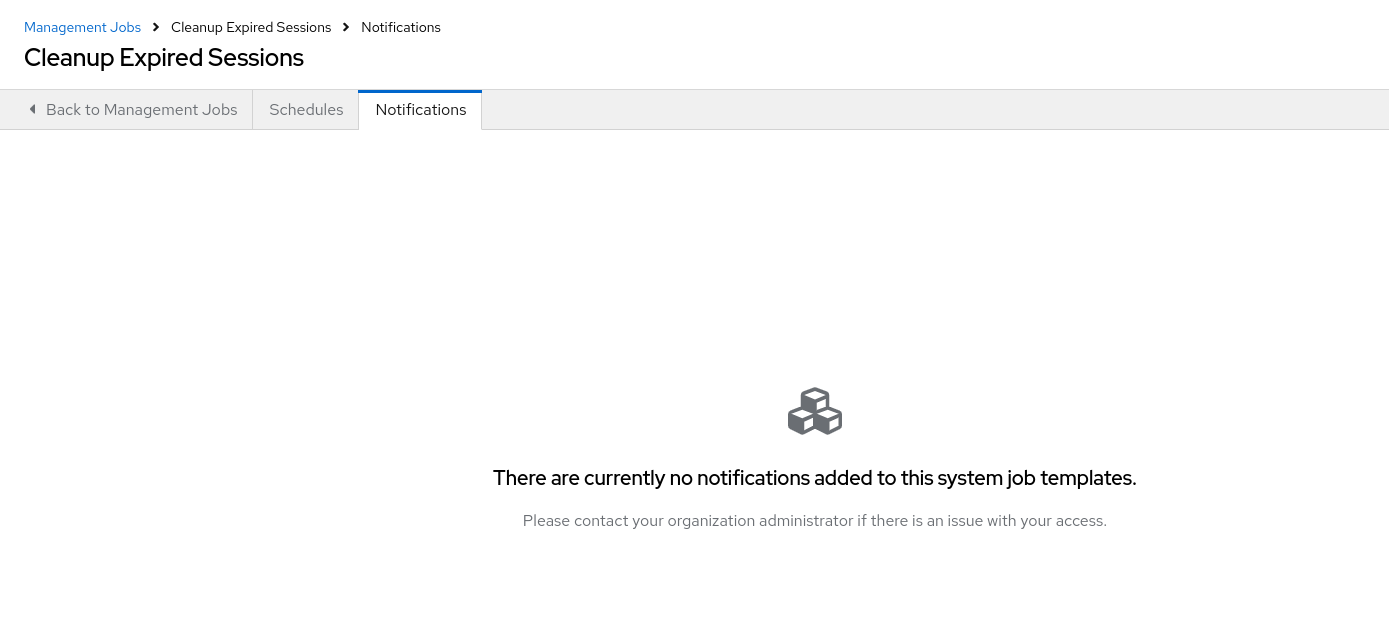

4.1.2. 通知の設定

管理ジョブに関連する通知を確認または設定するには、次の手順を使用します。

手順

- 特定のクリーンアップジョブは、Notifications タブを選択します。

存在しない場合は、自動化実行の使用 の 通知テンプレートの作成 を参照してください。

4.1.3. 期限切れセッションのクリーンアップ

期限切れのセッションを削除するには、Cleanup Expired Sessions の横にある起動アイコン (

![]() ) をクリックします。

) をクリックします。

期限切れのセッションの消去スケジュールを確認または設定するには、アクティビティーストリーム管理ジョブ向けに記載されているのと同じ手順を実行します。詳細は、削除のスケジューリング を参照してください。

アクティビティーストリーム管理ジョブの 通知 で説明されているのと同じ方法で、この管理ジョブに関連する通知を設定または確認することもできます。

詳細は、自動化実行の使用 の 通知機能 を参照してください。

4.1.4. 以前のジョブ履歴の削除

特定の日数以前のジョブ履歴を削除するには、Cleanup Job Details の横にある起動アイコン (

![]() ) をクリックします。

) をクリックします。

データの保存日数を入力し、 をクリックします。

Automation Controller リソース (プロジェクト、ジョブテンプレートなど) の最初のジョブ実行は、保持値に関係なく、Cleanup Job Details から除外されます。

古いジョブ履歴の消去スケジュールを確認または設定するには、アクティビティーストリーム管理ジョブ向けに記載されているのと同じ手順を実行します。

詳細は、スケジュールの 削除 を参照し てください。

この管理ジョブに関連付けられている通知は、Setting notifications for activity stream management jobs または information に説明したのと同じ方法で設定またはレビューすることもできます。詳細は link:https://docs.redhat.com/en/documentation/red_hat_ansible_automation_platform/2.5/html/using_automation_execution/controller-notificationsNotifiers] を参照してください。

第5章 インベントリーファイルのインポート

Automation Controller を使用すると、インベントリーファイルを最初から作成するのではなく、ソースコントロールから選択できます。ファイルは編集不可であり、ソースでインベントリーが更新されると、関連付けられている group_vars ファイルや host_vars ファイル、またはディレクトリーを含むプロジェクト内のインベントリーも、それに応じて更新されます。SCM タイプは、インベントリーファイルとスクリプトの両方を使用できます。インベントリーファイルとカスタムインベントリータイプはどちらもスクリプトを使用します。

インポートされたホストには、デフォルトで imported という説明があります。これは、特定のホストで _awx_description 変数を設定することでオーバーライドできます。たとえば、ソースの .ini ファイルからインポートする場合は、次のホスト変数を追加できます。

[main] 127.0.0.1 _awx_description="my host 1" 127.0.0.2 _awx_description="my host 2"

[main]

127.0.0.1 _awx_description="my host 1"

127.0.0.2 _awx_description="my host 2"

同様に、グループの説明もデフォルトでは imported ですが、_awx_description でオーバーライドすることもできます。

ソース管理で古いインベントリースクリプトを使用するには、自動化実行の使用 の 古いインベントリースクリプトのエクスポート を参照してください。

5.1. ソースコントロール管理インベントリーソースフィールド

使用するソースのフィールドは以下のとおりです。

-

source_project: 使用するプロジェクト。 -

source_path: ディレクトリーまたはファイルを示すプロジェクト内の相対パス。空白のままにしても、"" はプロジェクトの root ディレクトリーを示す相対パスを表します。 -

source_vars: "file" タイプのインベントリーソースに設定されている場合には、実行時に環境変数に渡されます。

補足

- プロジェクトを更新すると、そのプロジェクトが使用されているインベントリーの更新が自動的にトリガーされます。

- プロジェクトの更新は、インベントリーソースの作成直後にスケジュールされます。

- インベントリー更新もプロジェクト更新も、関連ジョブの実行中にブロックされることはありません。

-

大規模なプロジェクト (約 10 GB) がある場合、

/tmpのディスク領域が問題になる可能性があります。

インベントリーの Add source ページから、Automation Controller UI で場所を手動で指定できます。インベントリーソースの作成手順は、ソースの追加 を参照してください。

プロジェクトの更新時に、リストを更新して最新のソースコントロール管理 (SCM) 情報を使用します。インベントリーソースが SCM インベントリーソースとしてプロジェクトを使用しない場合、更新時にインベントリーのリストが更新されない可能性があります。

インベントリーが SCM ソースを含む場合、インベントリー更新のジョブの Details ページに、プロジェクト更新のステータスインジケーターとプロジェクト名が表示されます。

ステータスインジケーターはプロジェクト更新ジョブにリンクします。

プロジェクト名はプロジェクトにリンクします。

関連ジョブの実行中にインベントリーの更新を実行できます。

5.1.1. サポートされるファイルの構文

Automation Controller は、Ansible の ansible-inventory モジュールを使用してインベントリーファイルを処理し、Automation Controller で必要となる有効なインベントリー構文をすべてサポートします。

インベントリースクリプトを Python で記述する必要はありません。ソースフィールドには任意の実行可能ファイルを入力できます。そのファイルに対して chmod +x を実行し、Git にチェックインする必要があります。

以下は、Automation Controller がインポート用に読み取ることができる JSON 出力の実際の例です。

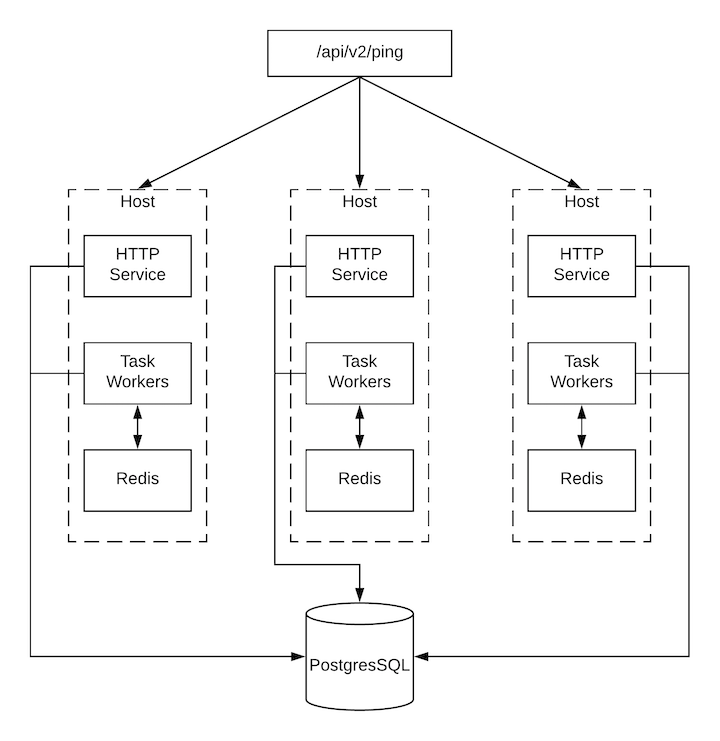

第6章 クラスタリング

クラスタリングでは、ホスト間で負荷が共有されます。各インスタンスは、UI および API アクセスのエントリーポイントとして機能できる必要があります。これにより、Automation Controller 管理者は必要な数のインスタンスの手前でロードバランサーを使用し、良好なデータ可視性を維持できるようになります。

負荷分散はオプションで、必要に応じて 1 つまたはすべてのインスタンスで受信することも可能です。

各インスタンスは、Automation Controller のクラスターに参加して、ジョブを実行する機能を拡張できる必要があります。これは、ジョブをどこで実行するかを指定するのではなく、ジョブをどこでも実行できる簡単なシステムです。また、自動化実行の使用 で説明されているように、クラスターインスタンスを インスタンスグループ と呼ばれる異なるプールまたはキューにグループ化することもできます。

Ansible Automation Platform は、Kubernetes を使用したコンテナーベースのクラスターをサポートしています。つまり、このプラットフォームに新しい Automation Controller インスタンスを、機能の変更や転換を行うことなくインストールできます。Kubernetes コンテナーを指定するインスタンスグループを作成できます。詳細は、自動化実行の使用 の インスタンスとコンテナーグループ セクションを参照してください。

サポート対象のオペレーティングシステム

クラスター環境の確立には、以下のオペレーティングシステムがサポートされます。

- Red Hat Enterprise Linux 8.7 以降である。

OpenShift での分離インスタンスと Automation Controller の実行の組み合わせはサポートされません。

6.1. セットアップに関する考慮事項

クラスターの初期セットアップを説明します。既存のクラスターをアップグレードするには、Ansible Automation Platform Upgrade and Migration Guide の Upgrade Planning を参照してください。

新規のクラスタリング環境では、次の重要な留意事項に注意してください。

- PostgreSQL はスタンドアロンインスタンスであり、クラスター化されていません。Automation Controller は、(ユーザーがスタンバイレプリカを設定した場合) レプリカ設定やデータベースフェイルオーバーを管理しません。

- クラスターを起動する場合は、データベースノードをスタンドアロンサーバーにする必要があります。PostgreSQL は Automation Controller ノードの 1 つにインストールしないでください。

-

PgBouncer は、Automation Controller を使用した接続プールには推奨されません。Automation Controller は、さまざまなコンポーネント間でのメッセージの送信に

pg_notifyを使用しているため、PgBouncerをトランザクションプールモードですぐに使用することはできません。 - 全インスタンスは他のすべてのインスタンスからアクセス可能であり、データベースにアクセスできる必要があります。ホストが安定したアドレスまたはホスト名を持つことも重要です (Automation Controller ホストの設定に応じて異なります)。

- 全インスタンスは、地理的に近い場所に配置する必要があります。インスタンス間はレイテンシーが低く信頼性のある接続を使用します。

-

クラスター環境にアップグレードするには、プライマリーインスタンスがインベントリーの

defaultグループに属し、defaultグループの最初のホストとしてリストされている必要があります。 - 手動のプロジェクトでは、顧客が手動で全インスタンスを同期して、一度に全インスタンスを更新する必要があります。

-

プラットフォームデプロイメントの

inventoryファイルは、保存または永続化する必要があります。新規インスタンスをプロビジョニングする場合は、インストールプログラムでパスワード、設定オプション、およびホスト名を使用する必要があります。

6.2. インストールおよび設定

仮想マシンベースのインストール用に新規インスタンスをプロビジョニングするには、inventory ファイルを更新して、セットアップ用 Playbook の再実行が含まれます。インベントリーファイルには、クラスターのインストール時に使用するすべてのパスワードと情報が含まれていることが重要です。含まれていない場合には、他のインスタンスが再設定される場合があります。インベントリーファイルには、単一のインベントリーグループ automationcontroller があります。

インスタンスはすべて、ジョブの起動先や Playbook イベントの処理、定期的なクリーンアップなど、タスクのスケジュールに関連するさまざまなハウスキーピングタスクを担当します。

リソースに対してグループが選択されていない場合は automationcontroller グループが使用されますが、他のグループが選択されている場合には automationcontroller グループは使用されません。

データベースグループは、外部 PostgreSQL を指定します。データベースホストを個別にプロビジョニングする場合、このグループは空である必要があります。

クラスター内の個々のコントローラーインスタンスで Playbook を実行すると、その Playbook の出力は、Automation Controller の WebSocket ベースのストリーミング出力機能の一部として、他のすべてのノードにブロードキャストされます。このデータブロードキャストは、インベントリー内の各ノードにプライベートルーティング可能なアドレスを指定し、内部アドレスを使用して処理する必要があります。

[automationcontroller] hostA routable_hostname=10.1.0.2 hostB routable_hostname=10.1.0.3 hostC routable_hostname=10.1.0.4 routable_hostname

[automationcontroller]

hostA routable_hostname=10.1.0.2

hostB routable_hostname=10.1.0.3

hostC routable_hostname=10.1.0.4

routable_hostname

routable_hostname の詳細は、RPM インストール の 一般的な変数 を参照してください。

Automation Controller の以前のバージョンでは、rabbitmq_host という変数名を使用していました。以前のバージョンのプラットフォームからアップグレードしようとしており、以前にインベントリーに rabbitmq_host を指定している場合は、アップグレードの前に、名前を rabbitmq_host から routable_hostname に変更してください。

6.2.1. Automation Controller と Automation Hub によって使用されるインスタンスとポート

Automation Controller で使用され、オンプレミスの Automation Hub ノードでも必要なポートとインスタンスは次のとおりです。

- ポート 80、443 (通常の Automation Controller ポートおよび Automation Hub ポート)

- ポート 22 (SSH - Ingress のみが必要)

- ポート 5432 (データベースインスタンス - データベースを外部インスタンスにインストールする場合は、Automation Controller インスタンスに対してこのポートを開く必要があります。)

6.3. ブラウザーの API によるステータスの確認およびモニタリング

Automation Controller は、クラスターの健全性を検証するために、/api/v2/ping にあるブラウザー API を使用して可能な限り多くのステータスを報告します。これには、以下のパラメーターが含まれます。

- HTTP 要求にサービスを提供するインスタンス

- クラスター内にある他の全インスタンスが出した最後のハートビートのタイムスタンプ

- これらのグループのインスタンスグループおよびインスタンスのメンバーシップ

実行中のジョブやメンバー情報など、インスタンスおよびインスタンスグループに関する詳細情報は、/api/v2/instances/ および /api/v2/instance_groups/ を参照してください。

6.4. インスタンスサービスおよび障害時の動作

各 Automation Controller インスタンスは、以下のさまざまなサービスで構成されており、これらのサービスは連携しています。

- HTTP サービス

- これには、Automation Controller アプリケーション自体と外部 Web サービスが含まれます。

- Callback receiver

- 実行中の Ansible ジョブからジョブイベントを受信します。

- Dispatcher

- 全ジョブを処理して実行するワーカーキューです。

- Redis

- このキー値ストアは、ansible-playbook からアプリケーションに伝搬されるイベントデータのキューとして使用されます。

- Rsyslog

- ログをさまざまな外部ロギングサービスに配信するために使用されるログ処理サービスです。

Automation Controller は、これらのサービスまたはそのコンポーネントのいずれかが失敗した場合に、すべてのサービスが再起動されるように設定されています。これらが短期間で頻繁に失敗する場合は、予期せぬ動作を引き起こすことなく修復できるように、インスタンス全体が自動的にオフラインになります。

クラスター環境のバックアップと復元は、クラスター環境のバックアップおよび復元 セクションを参照してください。

6.5. ジョブランタイムの動作

ジョブが実行され、Automation Controller の 通常 のユーザーにレポートされる方法は変わりません。システム側では、次の違いに注意してください。

ジョブが API インターフェイスから送信されると、ジョブはディスパッチャーキューにプッシュされます。各 Automation Controller インスタンスは、スケジューリングアルゴリズムを使用してそのキューに接続し、そこからジョブを受け取ります。クラスター内のどのインスタンスも、等しく処理を受け取り、タスクを実行する可能性があります。ジョブの実行中にインスタンスが失敗した場合、その作業は永続的に失敗したものとしてマークされます。

- プロジェクトの更新は、ジョブを実行する可能性のあるすべてのインスタンスで正常に実行されます。プロジェクトは、ジョブを実行する直前に、インスタンス上の正しいバージョンに同期されます。必要なリビジョンがすでにローカルでチェックアウトされており、Galaxy または Collections の更新が必要ない場合は、同期を実行できません。

-

同期が行われると、

launch_type = syncおよびjob_type = runのプロジェクト更新としてデータベースに記録されます。プロジェクトの同期によってプロジェクトのステータスやバージョンは変更されません。代わりに、プロジェクトが実行されているインスタンスでソースツリーのみが更新されます。 -

Galaxy または Collections からの更新が必要な場合は、同期が実行されて必要なロールをダウンロードします。これにより、

/tmp fileの領域がより多く消費されます。大規模なプロジェクト (約 10 GB) がある場合、/tmpのディスク領域が問題になる可能性があります。

6.5.1. ジョブの実行

デフォルトでは、ジョブが Automation Controller キューに送信されると、どのワーカーでもジョブを取得できます。ただし、ジョブを実行するインスタンスを制限するなど、特定のジョブを実行する場所を制御することができます。

インスタンスの一時的なオフライン化をサポートするために、各インスタンスで有効なプロパティーが定義されています。このプロパティーが無効になっている場合、そのインスタンスにはジョブは割り当てられません。既存のジョブは終了しますが、新しいジョブは割り当てられません。

トラブルシューティング

実行中の Automation Controller ジョブに対して cancel 要求を発行すると、Automation Controller は ansible-playbook プロセスに SIGINT を発行します。これにより、Ansible は新しいタスクのディスパッチを停止して終了しますが、多くの場合、すでにリモートホストにディスパッチされたモジュールタスクは完了するまで実行されます。この動作は、コマンドラインでの Ansible の実行中に Ctrl-c を押した場合と似ています。

ソフトウェアの依存関係に関しては、実行中のジョブがキャンセルされた場合、そのジョブは削除されますが、依存関係は残ります。

6.6. インスタンスのプロビジョニング解除

設定用 Playbook を再実行しても、インスタンスのプロビジョニングが自動的に解除されるわけではありません。これは現在、インスタンスが意図的にオフラインにされたのか、障害が原因でオフラインになったのかをクラスターが識別できないためです。代わりに、Automation Controller インスタンスの全サービスをシャットダウンした後に、他のインスタンスからプロビジョニング解除ツールを実行します。

手順

-

コマンド

automation-controller-service stopを使用して、インスタンスをシャットダウンするか、サービスを停止します。 別のインスタンスから次のプロビジョニング解除コマンドを実行して、Automation Controller クラスターからインスタンスを削除します。

awx-manage deprovision_instance --hostname=<name used in inventory file>

$ awx-manage deprovision_instance --hostname=<name used in inventory file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

以下は、プロビジョニング解除コマンドの例です。

awx-manage deprovision_instance --hostname=hostB

$ awx-manage deprovision_instance --hostname=hostBAutomation Controller でインスタンスグループのプロビジョニングを解除しても、インスタンスグループは自動的にプロビジョニング解除されたり削除されたりしません。詳細は、自動化実行の使用 の インスタンスグループのプロビジョニング解除 セクションを参照してください。

第7章 ポリシー適用の実装

自動化実行時におけるポリシー適用とは、ユーザーが Ansible Automation Platform インスタンスを操作する方法を制御するポリシーを、エンコードされたルールを使用して定義、管理、適用する機能です。ポリシーの適用によりポリシー管理が自動化され、セキュリティー、コンプライアンス、効率性が向上します。

OPA (Open Policy Agent) は、Ansible インスタンスからポリシーの決定をオフロードするポリシーエンジンです。ポリシー適用機能は、トリガーされると OPA に接続して設定で指定されているポリシーを取得し、自動化コンテンツにポリシールールを適用します。OPA は、ポリシー違反を検出するとアクションを停止し、ユーザーにポリシー違反に関する情報を提供します。

前提条件

Ansible Automation Platform インスタンスでポリシー適用を実装するには、以下が必要です。

- Ansible Automation Platform デプロイメントからアクセス可能な OPA サーバーへのアクセス。

- OPA サーバーに対する認証に必要な設定が行われた設定済みの Ansible Automation Platform。

- OPA、およびポリシーの記述に使用されている Rego 言語に関するある程度の知識。

ポリシー適用を正しく機能させるには、ポリシー設定で OPA サーバーを設定し、特定のポリシーを特定のリソースに関連付ける必要があります。たとえば、特定の組織、インベントリー、またはジョブテンプレートなどのリソースです。

OPA API V1 は、現在 Ansible Automation Platform でサポートされている唯一のバージョンです。

7.1. ポリシー適用設定

グローバル設定を変更することで、Ansible Automation Platform インスタンスが OPA と対話する方法を指定できます。

前提条件

- ポリシー適用を設定するには、管理者特権が必要です。

ポリシー設定で OPA サーバーを設定しないと、ジョブの実行時にポリシー評価が行われません。

手順

- ナビゲーションパネルから、 → → を選択します。

- Edit policy settings をクリックします。

Policy Settings ページで、次のフィールドに入力します。

- OPA Server hostname

- OPA サービスに接続するホストの名前を入力します。

- OPA server port

- OPA サービスに接続するポートを入力します。

- OPA authentication type

- OPA 認証タイプを選択します。

- OPA custom authentication header

- OPA 認証のリクエストヘッダーに追加するカスタムヘッダーを入力します。

- OPA request timeout

- 接続がタイムアウトするまでの秒数を入力します。

- OPA request retry count

- リクエストが失敗するまでの、OPA サービスへの接続を試行できる回数を入力します。

認証タイプに応じて、次のフィールドに入力する必要がある場合があります。

認証タイプとしてトークンを選択した場合:

- OPA authentication token

- OPA 認証トークンを入力します。

認証タイプとして証明書を選択した場合:

- OPA client certificate content

- mTLS 認証用の CA 証明書の内容を入力します。

- OPA client key content

- mTLS 認証用のクライアントキーを入力します。

- OPA CA certificate content

- mTLS 認証用の CA 証明書の内容を入力します。

Options という見出しの下に以下が表示されます。

- Use SSL for OPA connection

- OPA サービスへの SSL 接続を有効にするには、このボックスをオンにします。

- をクリックします。

7.2. OPA パッケージとルールを理解する

OPA ポリシーは、名前空間を持つルールの集合であるパッケージに編成されます。OPA ポリシーの基本構造は以下のとおりです。

ルールの構造の主要なコンポーネントは次のとおりです。

- パッケージの宣言

- ポリシーの名前空間を定義します。

- ルール

- ポリシーのロジックとそれが返す決定を定義します。

これらのコンポーネントを組み合わせて、[package]/[rule] 形式で OPA ポリシー名が構成されます。OPA ポリシー名は、適用ポイントの設定時に入力します。

7.3. 適用ポイントの設定

OPA サーバーと通信するように Ansible Automation Platform インスタンスを設定すると、ポリシーを適用する適用ポイントを設定できるようになります。

ポリシーをジョブテンプレート、インベントリー、または組織に関連付けることができます。適用は次のように実行されます。

- 組織

- 組織が所有するテンプレートから起動されたジョブは、ポリシーに違反すると失敗します。この設定により、組織の境界内での自動化を幅広く制御できます。

- インベントリー

- ポリシーに関連付けられたインベントリーを使用するジョブは、ポリシーに違反すると失敗します。この設定により、特定のインフラストラクチャーリソースへのアクセスを制御できます。

- ジョブテンプレート

- ポリシーに関連付けられたテンプレートから起動されたジョブは、関連付けられたポリシーに違反すると失敗します。この設定により、特定の自動化タスクを細かく制御できます。

ポリシーをリソースに関連付けないと、関連するジョブを実行してもポリシーの評価が行われません。

7.3.1. ポリシーを組織に関連付ける

ポリシーを組織に関連付けるには、次のステップを実行します。

手順

- ナビゲーションパネルから、 → を選択します。

Organizations ページで次の操作を行います。

-

既存の組織を編集するには、編集する組織を見つけ、鉛筆アイコン

をクリックして編集画面に移動します。

をクリックして編集画面に移動します。

- 新しい組織を作成するには、 をクリックします。

-

既存の組織を編集するには、編集する組織を見つけ、鉛筆アイコン

-

Policy enforcement という名前のフィールドに、実装するポリシーに関連付けられたクエリーパスを入力します。クエリーパスは

package/ruleという形式にする必要があります。 - をクリックし、 をクリックして設定を保存します。

7.3.2. ポリシーをインベントリーに関連付ける

ポリシーをインベントリーに関連付けるには、次のステップを実行します。

手順

- ナビゲーションパネルから → → を選択します。

Inventories ページで次の操作を行います。

-

既存のインベントリーを編集するには、編集するインベントリーを見つけ、鉛筆アイコン

をクリックして編集画面に移動します。

をクリックして編集画面に移動します。

- 新しいインベントリーを作成するには、 をクリックします。

-

既存のインベントリーを編集するには、編集するインベントリーを見つけ、鉛筆アイコン

-

Policy enforcement というタイトルのフィールドに、実装するポリシーに関連付けられたクエリーパスを入力します。クエリーパスは

package/ruleという形式にする必要があります。 - 既存のインベントリーを編集している場合は をクリックし、新しいインベントリーを作成している場合は をクリックします。

7.3.3. ポリシーをジョブテンプレートに関連付ける

ポリシーをジョブテンプレートに関連付けるには、次のステップを実行します。

手順

- ナビゲーションパネルから、 → を選択します。

Automation Templates ページで次の操作を行います。

-

既存のジョブテンプレートを編集するには、編集するジョブテンプレートを見つけ、鉛筆アイコン

をクリックして編集画面に移動します。

をクリックして編集画面に移動します。

- 新しいジョブテンプレートを作成するには、 をクリックします。

-

既存のジョブテンプレートを編集するには、編集するジョブテンプレートを見つけ、鉛筆アイコン

-

Policy enforcement というタイトルのフィールドに、実装するポリシーに関連付けられたクエリーパスを入力します。クエリーパスは

package/ruleという形式にする必要があります。 - 既存のジョブテンプレートを編集している場合は を、新しいジョブテンプレートを作成している場合は をクリックします。

7.4. ポリシー適用の入力と出力

次の入力と出力を使用して、ポリシー適用に使用するポリシーを作成します。

| 入力 | 型 | 説明 |

|---|---|---|

|

| Integer | ジョブの一意の識別子。 |

|

| String | ジョブテンプレート名。 |

|

| Datetime (ISO 8601) | ジョブが作成された日時を示すタイムスタンプ。 |

|

| Object | ジョブを作成したユーザーに関する情報。

|

|

| Object のリスト | ジョブ実行に関連付けられた認証情報。

|

|

| Object | ジョブに使用される実行環境の詳細。

|

|

| JSON | ジョブ実行用に提供される追加の変数。 |

|

| Integer | ジョブ実行に使用される並列プロセスの数。 |

|

| Integer | ジョブの対象となるホストの数。 |

|

| Object | ジョブを処理するインスタンスグループに関する情報。以下が含まれます。

|

|

| Object | ジョブ実行で使用されるインベントリーの詳細。以下が含まれます。

|

|

| Object | ジョブテンプレートに関する情報。以下が含まれます。

|

|

| 選択肢 (String) | ジョブ実行のタイプ。使用できる値は次のとおりです。

|

|

| String | ジョブタイプの判読可能な名前。 |

|

| Object のリスト | ジョブに関連付けられたラベル。以下が含まれます。

|

|

| 選択肢 (String) | ジョブが開始された方法。使用できる値は次のとおりです。

|

|

| String | ジョブ実行に適用される制限。 |

|

| Object | ジョブを開始したユーザーに関する情報。以下が含まれます。

|

|

| Object | ジョブに関連付けられた組織に関する情報。以下が含まれます。

|

|

| String | ジョブ実行で使用される Playbook。 |

|

| Object | ジョブに関連付けられたプロジェクトの詳細。以下が含まれます。

|

|

| String | SCM に使用する特定のブランチ。 |

|

| String | ジョブに使用する SCM リビジョン。 |

|

| Object | ワークフロージョブの詳細 (ジョブがワークフローの一部である場合)。 |

|

| Object | ワークフロージョブテンプレートの詳細。 |

次のコードブロックは、デモジョブテンプレートの起動以降の入力データ例を示しています。

| 入力 | 型 | 説明 |

|---|---|---|

|

| Boolean | アクションが許可されているかどうかを示します |

|

| String のリスト | アクションが許可されない理由 |

次のコードブロックは、OPA ポリシークエリーからの予想される出力の例を示しています。

第8章 Automation Controller のログ

Automation Controller ログへのアクセス方法は、Ansible Automation Platform が RPM ベースでインストールされているか、コンテナー化されているかによって異なります。

8.1. コンテナー化された Ansible Automation Platform の Automation Controller ログへのアクセス

コンテナー化された Ansible Automation Platform のログは特定のファイルに保存されません。アプリケーションログはコンテナー stdout に送信され、journald を使用して Podman によって処理されます。

Automation Controller に関連付けられている 3 つのコンテナーは次のとおりです。

-

automation-controller-rsyslog -

automation-controller-task -

automation-controller-web

各コンテナーの目的とログの検証方法は、コンテナー 化インストールでの 問題の特定 を 参照し てください。

8.2. RPM ベースの Ansible Automation Platform の Automation Controller ログへのアクセス

Automation Controller ログファイルには、次の 2 つの一元化された場所からアクセスできます。

-

/var/log/tower/ -

/var/log/supervisor/

/var/log/tower/ ディレクトリーでは、次の方法で取得されたログファイルを確認できます。

- tower.log: ジョブの実行時に発生するランタイムエラーなどのログメッセージを取得します。

- callback_receiver.log: Ansible ジョブの実行時にコールバックイベントを処理するコールバックレシーバーログを取得します。

- dispatcher.log: Automation Controller ディスパッチャワーカーサービスのログメッセージを取得します。

- job_lifecycle.log: ジョブ実行の詳細、ブロックの有無、ブロックの条件などを取得します。

- management_playbooks.log: 管理 Playbook の実行、およびメタデータのコピーといった分離ジョブの実行のログを取得します。

- rsyslog.err: 外部ロギングサービスへのログ送信時に、外部ロギングサービスでの認証で生じた rsyslog エラーを取得します。

- task_system.log: バックグラウンドで Automation Controller が実行しているタスクのログを取得します。たとえば、クラスターインスタンスの追加や、分析のための情報収集/処理に関連するログなどです。

- tower_rbac_migrations.log: rbac データベースの移行またはアップグレードに関するログを取得します。

- tower_system_tracking_migrations.log: コントローラーシステムによる移行またはアップグレードの追跡に関するログを取得します。

- wsbroadcast.log: コントローラーノードの websocket 接続のログを取得します。

/var/log/supervisor/ ディレクトリーでは、次の方法で取得されたログファイルを確認できます。

-

awx-callback-receiver.log:

supervisordで管理されている Ansible ジョブの実行時にコールバックイベントを処理するコールバックレシーバーのログを取得します。 - awx-daphne.log: WebUI の Websocket 通信のログを取得します。

- awx-dispatcher.log: ジョブの実行時など、タスクを Automation Controller インスタンスにディスパッチするときに発生するログを取得します。

-

awx-rsyslog.log:

rsyslogサービスのログを取得します。 - awx-uwsgi.log: アプリケーションサーバーである uWSGI に関連するログを取得します。

- awx-wsbroadcast.log: Automation Controller が使用する websocket サービスのログを取得します。

-

failure-event-handler.stderr.log:

/usr/bin/failure-event-handlerの supervisord サブプロセスの標準エラーを取得します。 -

supervisord.log:

supervisord自体に関連するログを取得します。 - wsrelay.log: websocket リレーサーバー内の通信ログをキャプチャーします。

- ws_heartbeat.log: ホスト上で実行しているサービスの健全性に関する定期的なチェックをキャプチャーします。

- rsyslog_configurer.log: 外部ロギングサービスによる認証に関連する rsyslog 設定アクティビティーをキャプチャーします。

/var/log/supervisor/ ディレクトリーには、全サービスの stdout ファイルも含まれます。

Automation Controller (および Ansible Automation Platform) が使用するサービスにより、次のログパスが生成されると予想されます。

- /var/log/nginx/

- /var/lib/pgsql/data/pg_log/

- /var/log/redis/

トラブルシューティング

エラーログは次の場所にあります。

-

Automation Controller サーバーエラーは

/var/log/towerに記録されます。 -

Supervisor のログは

/var/log/supervisor/にあります。 - Nginx Web サーバーのエラーは httpd エラーログに記録されます。

-

その他の Automation Controller のロギングニーズは

/etc/tower/conf.d/で設定します。

大半のブラウザーに組み込まれている JavaScript コンソールを使用してクライアント側の問題をチェックし、Red Hat カスタマーポータル (https://access.redhat.com/) 経由で Ansible にエラーを報告してください。

第9章 ロギングおよびアグリゲーション

ロギングは、詳細なログをサードパーティーの外部ログアグリゲーションサービスに送信する機能を提供します。このデータフィードに接続されたサービスは、Automation Controller の使用や技術の傾向に関する洞察を得るための手段として機能します。このデータを使用して、インフラストラクチャー内のイベントを分析し、異常を監視し、あるサービスのイベントを別のサービスのイベントと関連付けることができます。

Automation Controller に最も役立つデータのタイプは、ジョブファクトデータ、ジョブイベントまたはジョブ実行、アクティビティーストリームデータ、およびログメッセージです。データは、カスタムハンドラーで、またはインポートされたライブラリーを介して設計された最小限のサービス固有の調整を使用して、HTTP 接続を介して JSON 形式で送信されます。

Automation Controller によってインストールされる rsyslog のバージョンは、次の rsyslog モジュールを含みません。

- rsyslog-udpspoof.x86_64

- rsyslog-libdbi.x86_64

Automation Controller 外部のロギングは、以前は RHEL 提供の rsyslog パッケージを使用して実行していた可能性がありますが、Automation Controller をインストールした後は、Automation Controller 提供の rsyslog パッケージのみを使用する必要があります。

Automation Controller インスタンスでのシステムログの記録にすでに rsyslog を使用している場合は、別の rsyslog プロセス (Automation Controller が使用するのと同じバージョンの rsyslog を使用) を実行し、別の /etc/rsyslog.conf ファイルを指定することで、引き続き rsyslog を使用して Automation Controller の外部からのログを処理できます。

外部ロガーがオフラインになった場合に Automation Controller の rsyslog プロセスで未送信のメッセージを処理する方法を、/api/v2/settings/logging/ エンドポイントを使用して設定します。

LOG_AGGREGATOR_ACTION_MAX_DISK_USAGE_GB: rsyslogd アクションキューの最大ディスク永続性 (GB 単位)。外部ログアグリゲーターの停止時に保存するデータの量 (ギガバイト単位) を指定します (デフォルトは 1)。

rsyslogd queue.maxDiskSpace設定に相当します。LOG_AGGREGATOR_ACTION_QUEUE_SIZE: ログアクションキューに保存できるメッセージの最大数。保存されるメッセージの数に応じて、rsyslog アクションキューをどれだけ大きくするかを定義します。これはメモリー使用量に影響を及ぼす可能性があります。キューがこの数の 75% に達すると、キューはディスクへの書き込みを開始します (

rsyslogのqueue.highWatermark)。90% に達すると、NOTICE、INFO、DEBUGメッセージが破棄され始めます (queue.discardMarkと 'queue.discardSeverity=5`)。アクションの

rsyslogd queue.size設定に相当します。

これは、LOG_AGGREGATOR_MAX_DISK_USAGE_PATH で指定されたディレクトリーにファイルを保存します。

-

LOG_AGGREGATOR_MAX_DISK_USAGE_PATH: 外部ログアグリゲーターの停止後に再試行する必要があるログを保存する場所を指定します (デフォルトは/var/lib/awx)。rsyslogd queue.spoolDirectory設定に相当します。

たとえば、Splunk がオフラインになった場合、rsyslogd は Splunk がオンラインに戻るまでディスクにキューを保存します。デフォルトでは、(Splunk がオフラインの間) 最大 1 GB のイベントが保存されますが、必要に応じて 1 GB 超に増やすことも、キューを保存するパスを変更することもできます。

9.1. ロガー

以下は、予測可能な構造化形式または半構造化形式で大量の情報を提供する特別なロガー (汎用的なサーバーログを構成する awx は除く) です。これらは、API からデータを取得するときと同じ構造を使用します。

-

job_events: Ansible コールバックモジュールから返されるデータを渡します。 -

activity_stream: アプリケーション内のオブジェクトに対する変更の記録を表示します。 -

system_tracking: Ansiblesetupモジュールによって収集されたファクトデータを提供します。つまり、Enable Fact Cache を選択した状態でジョブテンプレートを実行する場合は、gather_facts: trueになります。 -

awx: 通常はファイルに書き込まれるログを含む、汎用的なサーバーログを提供します。これには、すべてのログが有する標準メタデータが含まれます。ただし、含まれるのはログステートメントからのメッセージのみです。

これらのロガーは、INFO のログレベルのみを使用します。例外は awx ロガーで、これはどのレベルでも使用できます。

さらに、標準の Automation Controller ログも、同じメカニズムで配信できます。ローカルの設定ファイルで複雑なディクショナリーを操作せずに、これら 5 つのデータソースをそれぞれ有効または無効にする方法や、標準の Automation Controller ログから使用するログレベルを調整する方法は明らかです。

ナビゲーションパネルから、 → → を選択して、Automation Controller のロギングコンポーネントを設定します。

9.1.1. ログメッセージスキーマ

全ロガーに対する共通のスキーマ

-

cluster_host_id: Automation Controller クラスター内のホストの一意識別子。 -

level: イベントの重要性をほぼ反映する、標準の Python ログレベル。すべてのデータロガーは「レベル」の一部としてINFOレベルを使用しますが、他の Automation Controller ログは必要に応じて異なるレベルを使用します。 -

logger_name: 設定で使用するロガー名 (たとえば "activity_stream")。 -

@timestamp: ログの時刻。 -

path: ログが生成されたコードのファイルパス。

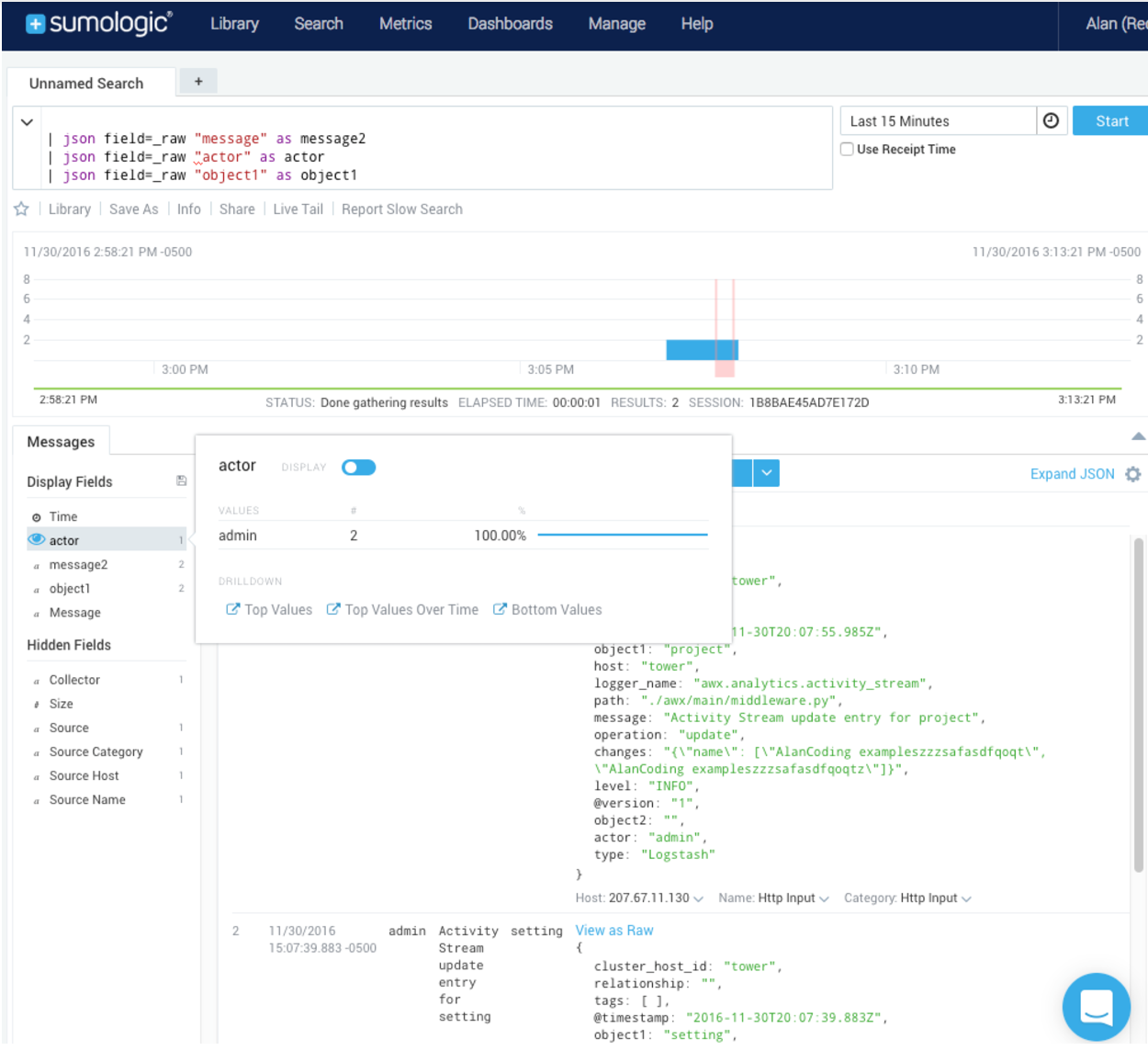

9.1.2. アクティビティーストリームスキーマ

これは、Log message schema にリストされているすべてのロガーに共通のフィールドを使用します。

次の追加フィールドがあります。

-

actor: ログに記述されたアクションを行ったユーザーのユーザー名。 -

changes: 変更されたフィールド、および古い値または新しい値の概要 (JSON)。 -

operation: "associate" など、アクティビティーストリームにログ記録された変更の基本カテゴリー。 -

object1: 操作を行うプライマリーオブジェクトに関する情報。アクティビティーストリームに表示する内容と一貫性があります。 -

object2: 該当する場合には、アクションに関連する 2 つ目のオブジェクト。

このロガーは、ジョブイベントに保存されているデータを反映します。ただし、ロガーの予期される標準フィールドと競合する場合を除きます (この場合、フィールドはネストされます)。特に、job_event モデルのフィールド host は、event_host として指定されます。ペイロード内にはサブディクショナリーフィールド event_data もあり、これには Ansible イベントの詳細に応じて異なるフィールドが含まれます。

このロガーには、ログメッセージスキーマ の共通フィールドも含まれます。

9.1.3. スキャン/ファクト/システム追跡データスキーマ

これらには、サービス、パッケージまたはファイルの詳細なディクショナリータイプのフィールドが含まれます。

services: サービススキャンの場合、このフィールドが含まれ、サービスの名前に基づいたキーを含みます。注記名前の Elastic Search ではピリオドは使用できず、ログフォーマッターによって "_" に置き換えられます。

-

package: パッケージスキャンからのログメッセージに含まれます。 -

files: ファイルスキャンからのログメッセージに含まれます。 -

host: スキャンを適用するホストの名前です。 -

inventory_id: ホストが含まれるインベントリー ID です。

このロガーには、ログメッセージスキーマ の共通フィールドも含まれます。

9.1.4. ジョブステータスの変更

この情報ソースは、ジョブイベントと比較してジョブ状態の変化に関する情報は少量とし、ジョブテンプレートをベースとするジョブ以外で、統合されたジョブタイプに対する変更を取得します。

このロガーには、ログメッセージスキーマ の共通フィールドと、ジョブモデルに存在するフィールドも含まれます。

9.1.5. Automation Controller のログ

このロガーには、ログメッセージスキーマ の共通フィールドも含まれます。

さらに、ログメッセージを含む msg フィールドが含まれます。エラーには別の traceback フィールドが含まれます。ナビゲーションパネルから、 → → を選択します。Logging Settings ページで をクリックし、ENABLE EXTERNAL LOGGING オプションを使用して、ロギングコンポーネントを有効または無効にします。

9.1.6. ログアグリゲーターサービス

ログアグリゲーターサービスは、以下の監視またはデータ分析システムと連携します。

9.1.6.1. Splunk

Automation Controller の Splunk ロギング統合では、Splunk HTTP Collector を使用します。SPLUNK ログアグリゲーターを設定する場合は、次の例のように、完全な URL を HTTP Event Collector ホストに追加します。

Splunk HTTP Event Collector はデフォルトでポート 8088 をリッスンするため、受信要求が正常に処理されるように、LOG_AGGREGATOR_HOST に完全な HEC イベント URL (ポート番号を含む) を指定する必要があります。

一般的な値を次の例に示します。

HTTP Event Collector の設定の詳細は、Splunk のドキュメント を参照してください。

9.1.6.2. Loggly

Loggly の HTTP エンドポイントを介したログ送信の詳細は、Loggly のドキュメント を参照してください。

Loggly は、次の例の Logging Aggregator フィールドに示す URL 規則を使用します。

9.1.6.3. Sumologic

Sumologic では、JSON ファイルに含まれる検索基準を作成します。JSON ファイルには、必要なデータを収集するのに使用するパラメーターが指定されています。

9.1.6.4. Elastic stack (以前の ELK stack)

独自のバージョンの Elastic Stack をセットアップしている場合、必要な変更は、logstash logstash.conf ファイルに次の行を追加するだけです。

filter {

json {

source => "message"

}

}

filter {

json {

source => "message"

}

}Elastic 5.0.0 で後方互換性のない変更が導入され、使用するバージョンによっては、異なる設定が必要になる可能性があります。

9.2. ロギングのセットアップ

任意のアグリゲータタイプへのロギングをセットアップするには、次の手順を使用します。

手順

- ナビゲーションパネルから、 → → を選択します。

Logging settings ページで、 をクリックします。

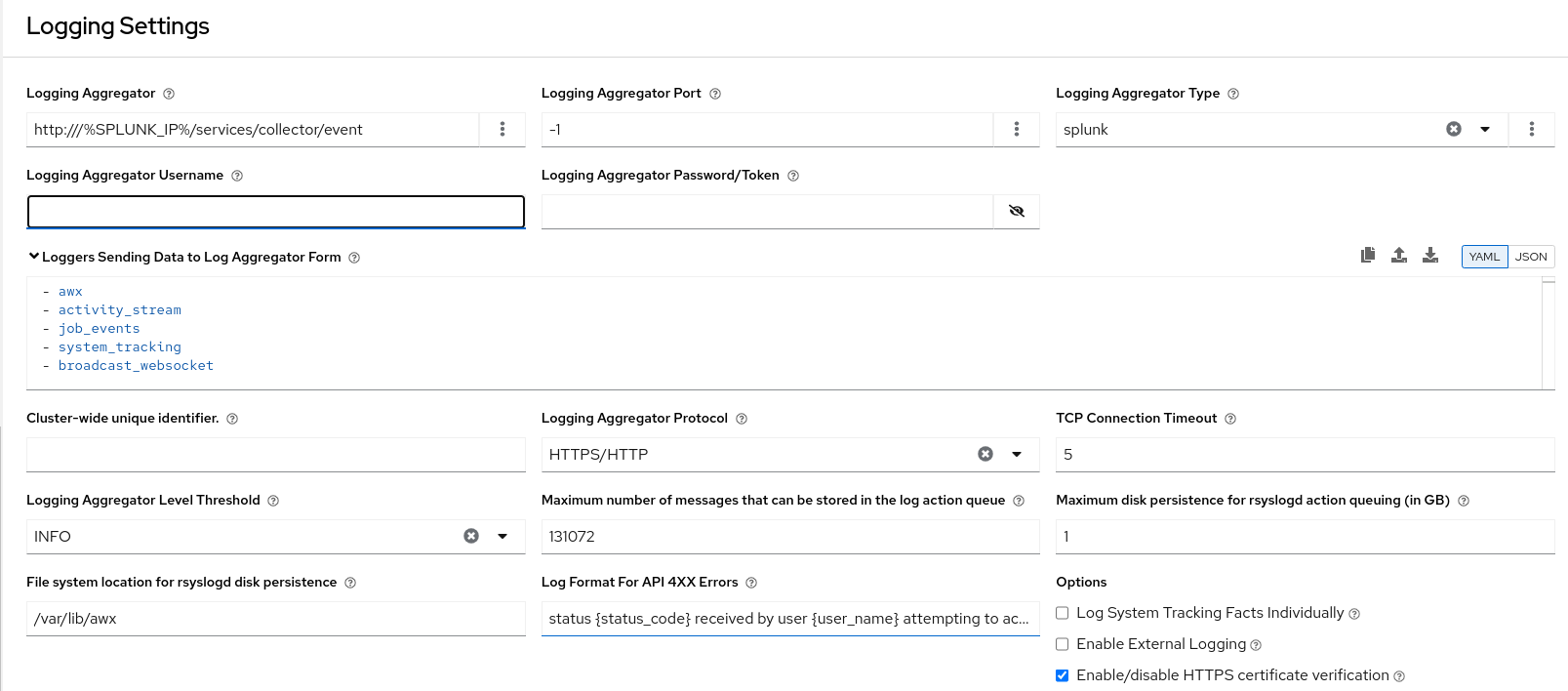

以下のオプションを設定できます。

- Logging Aggregator: ログを送信するホスト名または IP アドレスを入力します。

Logging Aggregator Port: アグリゲーターのポートが必要な場合は、ポートを指定します。

注記接続タイプが HTTPS の場合、ホスト名をポート番号付きの URL として入力できます。その後はポートを再度入力する必要はありません。ただし、TCP 接続と UDP 接続は、URL ではなく、ホスト名とポート番号の組み合わせによって特定されます。したがって、TCP 接続または UDP 接続の場合は、指定されたフィールドでポートを指定します。代わりに URL が Logging Aggregator フィールドに入力された場合、そのホスト名部分がホスト名として抽出されます。

Logging Aggregator Type: クリックして、リストからアグリゲータサービスを選択します。

- Logging Aggregator Username: 必要に応じて、ロギングアグリゲーターのユーザー名を入力します。

- Logging Aggregator Password/Token: 必要に応じて、ロギングアグリゲーターのパスワードを入力します。

-

Loggers to Send Data to the Log Aggregator Form: デフォルトでは、4 種類のデータすべてが事前に入力されています。各データ型の追加情報を表示するには、フィールドの横にあるツールチップアイコン

をクリックします。不要なデータ型を削除します。

をクリックします。不要なデータ型を削除します。

- Cluster wide unique identifier: これを使用してインスタンスを一意に識別します。

- Logging Aggregator Protocol: クリックして、ログアグリゲーターと通信するための接続タイプ (プロトコル) を選択します。その後に表示されるオプションは、選択したプロトコルによって異なります。

- TCP Connection Timeout: 接続タイムアウトを秒単位で指定します。このオプションは、HTTPS および TCP ログアグリゲータープロトコルにのみ適用されます。

- Logging Aggregator Level Threshold: ログハンドラーで報告する重大度のレベルを選択します。

-

Maximum number of messages that can be stored in the log action queue: 保存されるメッセージの数に応じて

rsyslogアクションキューがどれだけ大きくなるかを定義します。これはメモリー使用量に影響を及ぼす可能性があります。キューがこの数の 75% に達すると、キューはディスクへの書き込みを開始します (rsyslogのqueue.highWatermark)。90% に達すると、NOTICE、INFO、およびDEBUGメッセージが破棄され始めます (queue.discardMarkとqueue.discardSeverity=5)。 -

Maximum disk persistence for rsyslogd action queuing (in GB):

rsyslogアクションによる受信メッセージの処理に時間がかかる場合 (デフォルトは 1) に、保存するデータ量 (ギガバイト単位) です。アクションのrsyslogd queue.maxdiskspace設定と同等です (例:omhttp)。これは、LOG_AGGREGATOR_MAX_DISK_USAGE_PATHで指定されたディレクトリーにファイルを保存します。 -

File system location for rsyslogd disk persistence: 外部ログアグリゲーターの停止後に再試行する必要のあるログを永続化する場所 (デフォルトは

/var/lib/awx)。rsyslogd queue.spoolDirectory設定に相当します。 - Log Format For API 4XX Errors: 特定のエラーメッセージを設定します。詳細は、API 4XX エラー設定 を参照してください。

以下のオプションを設定します。

Log System Tracking Facts Individually: ツールチップアイコン

をクリックすると、オンに切り替えるか、デフォルトのままオフにしておくかなど、追加情報が表示されます。

をクリックすると、オンに切り替えるか、デフォルトのままオフにしておくかなど、追加情報が表示されます。

選択したロギングアグリゲーションのエントリーを確認します。次の例は Splunk 用にセットアップされています。

- Enable External Logging: ログを外部ログアグリゲーターに送信する場合は、このチェックボックスを選択します。

- Enable/disable HTTPS certificate verification: HTTPS ログプロトコルの証明書検証はデフォルトで有効になっています。接続を確立する前に、外部ログアグリゲーターから送信された HTTPS 証明書をログハンドラーで検証する場合は、このチェックボックスをオンにします。

Enable rsyslogd debugging: このチェックボックスを選択すると、

rsyslogdの詳細度の高いデバッグが有効になります。外部ログアグリゲーションの接続に関する問題のデバッグに役立ちます。- をクリックするか、変更を破棄する場合は をクリックします。

9.3. API 4XX エラー設定

要求で問題が発生すると、API は通常、エラーとともに 400 番台の HTTP エラーコードを返します。この場合、次のパターンに従ったエラーメッセージがログに生成されます。

' status {status_code} received by user {user_name} attempting to access {url_path} from {remote_addr} '

' status {status_code} received by user {user_name} attempting to access {url_path} from {remote_addr} 'メッセージは必要に応じて設定できます。デフォルトの API 4XX エラーログメッセージの形式を変更するには、次の手順を使用します。

手順

- ナビゲーションパネルから、 → → を選択します。

- Logging settings ページで、 をクリックします。

- Log Format For API 4XX Errors フィールドを変更します。

{} で囲まれた項目はログエラー発生時に置換されます。次の変数を使用できます。

- status_code: API が返す HTTP ステータスコード。

- user_name: API 要求を行うときに認証されたユーザーの名前。

- url_path: 呼び出される URL のパス部分 (別名 API エンドポイント)

- remote_addr :Automation Controller が受信したリモートアドレス。

- error: API によって返されるエラーメッセージ。エラーが指定されていない場合は、HTTP ステータスをテキストで返します。

9.4. ロギングのトラブルシューティング

ロギングアグリゲーション

テストボタンを使用して、設定済みのロギングサービスに http または https 経由でメッセージを送信したものの、メッセージを受信しなかった場合は、/var/log/tower/rsyslog.err ログファイルを確認してください。http または https の外部ロギングサービスで rsyslog を認証するときにエラーが発生した場合、ここにエラーが保存されます。エラーがない場合、このファイルは存在しないことに注意してください。

API 4XX エラー

これらのメッセージのログ形式を変更することにより、4XX エラーの API エラーメッセージを含めることができます。API 4XX エラー設定 を参照してください。

LDAP

LDAP アダプターのロギングメッセージを有効にできます。詳細は、API 4XX エラー設定 を参照してください。

SAML

LDAP のログを有効にするのと同じ方法で、SAML アダプターのメッセージのロギングを有効にできます。

第10章 メトリクス

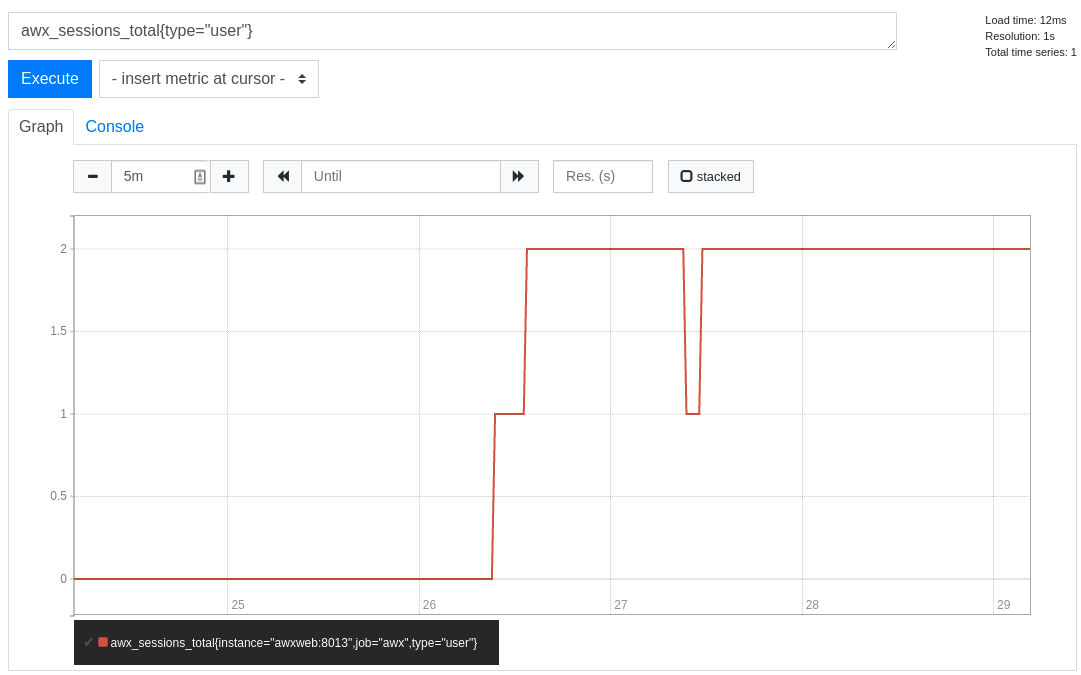

API ではメトリクスエンドポイント /api/controller/v2/metrics/ が使用できます。このメトリクスエンドポイントは、Automation Controller に関する即時のメトリクスを生成します。メトリクスは、オープンソースプロジェクトの Prometheus といったシステム監視ソフトウェアで使用できます。

metrics/ エンドポイントに表示されるデータのタイプは、Content-type: text/plain および application/json です。

このエンドポイントからは、アクティブなユーザーセッションの数や、各 Automation Controller ノードでアクティブに実行されているジョブの数など、有用な情報が得られます。

Automation Controller メトリクスエンドポイントにアクセスし、このデータを時系列データベースに保存することで、Automation Controller からこれらのメトリクスを収集するように Prometheus を設定できます。

その後、クライアントは Prometheus を他のソフトウェア (Grafana や Metricbeat など) と組み合わせて使用して、データを視覚化したりアラートを設定したりできます。

10.1. Prometheus のセットアップ

Prometheus をセットアップして使用するには、仮想マシンまたはコンテナーに Prometheus をインストールする必要があります。

詳細は、First steps with Prometheus ドキュメントを参照してください。

手順

Prometheus 設定ファイル (通常は

prometheus.yml) で、<token_value>、作成した Automation Controller ユーザーの有効なユーザー名とパスワード、および<controller_host>を指定します。注記あるいは、OAuth2 トークン (

/api/v2/users/N/personal_tokens/で生成可能) を指定することもできます。デフォルトでは、この設定はユーザー名 =admin、パスワード =passwordであるユーザーを想定しています。次の例は、Automation Controller で Prometheus を認証するために

/api/v2/tokensエンドポイントで作成した OAuth2 トークンを使用し、Automation Controller のメトリクスエンドポイントの URL が/https://controller_host:443/metricsである場合の有効な収集設定です。Copy to Clipboard Copied! Toggle word wrap Toggle overflow アラートやサービスディスカバリー設定など、Prometheus の他の要素を設定する方法は、Prometheus configuration ドキュメントを参照してください。

Prometheus がすでに実行中の場合には、再読み込みしたエンドポイントに POST 要求を送信するか、Prometheus プロセスまたはサービスを強制終了し、Prometheus を再起動して設定の変更を適用する必要があります。

ブラウザーを使用して

/http://<your_prometheus>:9090/graphにある Prometheus UI のグラフに移動し、いくつかのクエリーをテストします。たとえば、awx_sessions_total{type="user"}を実行すると、現在のアクティブな Automation Controller ユーザーセッションの数をクエリーできます。

次のステップ

その他のクエリー方法は、インスタンスの Automation Controller API のメトリクスエンドポイント (api/v2/metrics) を参照してください。

第11章 Ansible Automation Platform と Automation Controller のサブスクリプション管理

Ansible Automation Platform は、使用状況の監視、サブスクリプションのアクティブ化、Red Hat サブスクリプション要件に対するコンプライアンス維持を行う機能を提供します。

11.1. ホストメトリクスとサブスクリプション

ホストメトリクスを使用すると、ノードの使用状況を正確にカウントし、サブスクリプションのコンプライアンスを確保できます。たとえば、ホストが使用されなくなった場合や、サブスクリプションの合計数にカウントされるべきでない場合は、そのホストを論理削除できます。

11.1.1. ホストメトリクスダッシュボード

ホストメトリクスを表示するには、ナビゲーションペインで → を選択します。

ホストメトリクスダッシュボードには、管理対象ホストごとに次のような自動化実行の概要が表示されます。

- ホストの最初および最後の自動化。

- ホストに対して自動化が実行された回数、または実行が試行された回数。

- 管理対象ホストが削除された回数。

ホスト上で自動化が実行された回数を表示する機能により、次のことが可能になります。

- 最も頻繁に自動化されるホストを表示します。

- 自動化環境の範囲をより正確に反映します。

11.1.1.1. 論理削除

論理削除により、廃止されたホストをホストメトリクスビューから削除し、潜在的な管理対象ノード数から除外できます。さらに、次のホストタイプも削除できます。

- CI-CD やテスト専用に使用される一時的な、一意にプロビジョニングされたホスト。

- ベンチプロビジョニングまたは一時ホスト。

- 廃止され、自動化されることのない古いホスト。

論理削除は、正当なユースケースシナリオのみを対象としています。たとえば、ノードのリサイクルを目的として、サブスクリプションのカウントに違反する目的で使用することはできません。詳細は、How are "managed nodes" defined as part of the Red Hat Ansible Automation Platform offering? を参照してください。

11.2. Red Hat Ansible Automation Platform のライセンス認証

Red Hat Ansible Automation Platform は、Ansible Automation Platform の使用を許可するために、利用可能なサブスクリプションまたはサブスクリプションマニフェストを使用します。

サブスクリプションを取得するには、次のいずれかを実行できます。

- Ansible Automation Platform を起動するときに、Red Hat のユーザー名とパスワード、サービスアカウントの認証情報、または Satellite の認証情報を使用します。

- Red Hat Ansible Automation Platform インターフェイスを使用するか、Ansible Playbook で手動でサブスクリプションマニフェストファイルをアップロードします。

11.2.1. 認証情報によるライセンス認証

Ansible Automation Platform を初めて起動すると、Ansible Automation Platform サブスクリプションウィザードが自動的に表示されます。組織管理者の場合は、Red Hat サービスアカウントを作成 し、クライアント ID とクライアントシークレットを使用してサブスクリプションを取得して Ansible Automation Platform に直接インポートできます。

管理者アクセス権がない場合は、ユーザー名とパスワード タブに Red Hat のユーザー名とパスワードを入力して、サブスクリプションを検索し、Ansible Automation Platform インスタンスに追加できます。

初めてログインしてプラットフォームをアクティベートすると、デフォルトで Automation Analytics がオプトインされます。これは、Red Hat がユーザーエクスペリエンスを大きく改善し、製品を改良する上で役立ちます。Ansible Automation Platform をアクティベートした後、次の手順でオプトアウトできます。

- ナビゲーションパネルから、 → → を選択します。

- Gather data for Automation Analytics オプションのチェックボックスをオフにします。

- をクリックします。

手順

- Red Hat Ansible Automation Platform にログインします。

- サブスクリプションウィザードで Service Account タブを選択します。

- Client ID と Client secret を入力します。

Subscription リストからサブスクリプションを選択します。

注記クラスターノードが Subscription Manager を通じて Satellite に登録されている場合は、Satellite タブに Satellite のユーザー名とパスワードを入力することもできます。

- 使用許諾契約書を確認し、I agree to the End User License Agreement を選択します。

- をクリックします。

検証

サブスクリプションが承認されると、サブスクリプションの詳細が表示されます。Compliant のステータスは、サブスクリプションが、サブスクリプションカウント内で自動化したホストの数に準拠していることを示します。それ以外の場合、ステータスは Out of Compliance と表示さます。これは、サブスクリプション内のホスト数を超えていることを示しています。表示されるその他の重要な情報は次のとおりです。

- 自動化されたホスト

- ライセンス数を消費するジョブによって自動化されたホスト数

- インポートされたホスト

- すべてのインベントリーソースを考慮したホスト数 (残りのホストには影響しません)

- 残りのホスト

- 合計ホスト数から自動化されたホストを差し引いた数

11.2.2. マニフェストファイルによるライセンス認証

サブスクリプションマニフェストがある場合は、Red Hat Ansible Automation Platform インターフェイスを使用してマニフェストファイルをアップロードできます。

初めてログインしてプラットフォームをアクティベートすると、デフォルトで Automation Analytics がオプトインされます。これは、Red Hat がユーザーエクスペリエンスを大きく改善し、製品を改良する上で役立ちます。Ansible Automation Platform をアクティベートした後、次の手順でオプトアウトできます。

- ナビゲーションパネルから、 → → を選択します。

- Gather data for Automation Analytics オプションのチェックボックスをオフにします。

- をクリックします。

前提条件

Red Hat カスタマーポータルから Red Hat サブスクリプションマニフェストファイルをエクスポートしている。詳細は、マニフェストファイルの取得 を 参照してください。

手順

Red Hat Ansible Automation Platform にログインします。

- すぐにサブスクリプションウィザードが表示されない場合は、 → に移動します。

- Subscription manifest タブを選択します。

- をクリックして、マニフェストファイルを選択します。

- 使用許諾契約書を確認し、I agree to the End User License Agreement を選択します。

をクリックします。

注記サブスクリプションウィザードページで ボタンが無効になっている場合は、USERNAME と PASSWORD フィールドをクリアします。

検証

サブスクリプションが承認されると、サブスクリプションの詳細が表示されます。Compliant のステータスは、サブスクリプションが、サブスクリプションカウント内で自動化したホストの数に準拠していることを示します。それ以外の場合、ステータスは Out of Compliance と表示さます。これは、サブスクリプション内のホスト数を超えていることを示しています。表示されるその他の重要な情報は次のとおりです。

- 自動化されたホスト

- ジョブによって自動化されたホスト数。サブスクリプション数を消費します。

- インポートされたホスト

- すべてのインベントリーソースを考慮したホスト数 (残りのホストには影響しません)

- 残りのホスト

- 合計ホスト数から自動化されたホストを差し引いた数

11.3. サブスクリプションのコンプライアンスを維持する

サブスクリプションには、次の 2 つのステータスがあります。

- Compliant: サブスクリプションが、サブスクリプション数以内の自動化したホストの数に対して適切であることを示します。

- Out of compliance: サブスクリプション内のホスト数を超えていることを示します。

コンプライアンスは次のように計算されます。

managed > manifest_limit => non-compliant managed =< manifest_limit => compliant

managed > manifest_limit => non-compliant

managed =< manifest_limit => compliant

ここで、managed は、削除されていない一意のマネージドホストの数、manifest_limit はサブスクリプションマニフェスト内のマネージドホストの数に置き換えます。

表示されるその他の重要な情報は次のとおりです。

- Hosts automated: ジョブによって自動化されたホストの数。ライセンス数を消費します。

- Hosts imported: すべてのインベントリーソースにおいて一意のホスト名を考慮したホスト数。この数は、残りのホスト数 (Hosts remaining) には影響しません。

- Hosts remaining: 自動化されたホストの数を差し引いたホスト数。

- Hosts deleted: 削除されたホスト数。ライセンス容量が開放されます。

- Active hosts previously deleted: 以前に削除され、現在アクティブになっているホスト数。

たとえば、ホスト 10 台分のサブスクリプションがあるとします。

- 最初は 9 台のホストでしたが、ホストを 2 台追加してから、3 台削除しました。その結果、ホストが 8 台になりました (コンプライアンス準拠)。

- 3 台のホストを再び自動化したところ、ホストが 11 台になり、サブスクリプションの上限である 10 を超えました (コンプライアンス非準拠)。

- ホストを削除する場合は、サブスクリプションの詳細を更新して、数とステータスの変更を確認します。

11.3.1. ユーザーインターフェイスで自動化されたホストを表示する

手順

ナビゲーションパネルで → を選択して、たとえば自動化や削除されたホストなど、ホストに関連付けられたアクティビティーを表示します。

それぞれの一意のホスト名がリストされ、ユーザーの設定に応じて並べ替えられます。

注記

注記スケジュールされたタスクはこれらの値を毎週自動的に更新し、最後に自動化されたのが 1 年以上前であるホストのジョブを削除します。

必要なホストを選択し、 をクリックして、ホストメトリクスビューから不要なホストを直接削除します。

これらは論理的に削除されるため、レコードは削除されませんが、使用されないため、サブスクリプションにはカウントされません。

11.3.2. CLI で自動化されたホストを表示する

Automation Controller は、コマンドラインインターフェイス (CLI) を通じて、ホストメトリクスデータとホストメトリクス概要の CSV 出力を生成する方法を提供します。API を介してホストを一括して論理削除することもできます。

11.3.2.1. awx-manage ユーティリティー

Ansible Automation Platform でホストメトリクスデータと関連するクラスター情報を収集および管理するには、awx-manage ユーティリティーを使用します。

手順

awx-manageユーティリティーは次のオプションをサポートしています。awx-manage host_metric --csv

awx-manage host_metric --csvCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドは、ホストメトリクスデータ、ホストメトリクス概要ファイル、およびクラスター情報ファイルを生成します。配布および共有用にすべてのファイルを 1 つの tar ファイルにパッケージ化するには、次のコマンドを使用します。

awx-manage host_metric --tarball

awx-manage host_metric --tarballCopy to Clipboard Copied! Toggle word wrap Toggle overflow 各ファイルに出力する行数 (

<n>) を指定するには、次のようにします。awx-manage host_metric --tarball --rows_per_file <n>

awx-manage host_metric --tarball --rows_per_file <n>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - その後、Automation Analytics は JSON ファイルを受信して使用します。

11.3.3. API エンドポイントを使用して自動化されたホストを削除する

API は削除されていないレコードのみをリストし、last_automation 列と used_in_inventories 列で並べ替えることができます。

ホストメトリクス API エンドポイント api/v2/host_metric と以下を使用して、ホストを論理削除することもできます。

api/v2/host_metric <n> DELETE

月次でスケジュールされたタスクでは、ホストを使用するジョブで最後に自動化されたのが 1 年以上前のジョブが、ホストメトリクステーブルから自動的に削除されます。

第12章 metrics-utility による使用状況レポート

Ansible Automation Platform メトリクスユーティリティーツール (metrics-utility) は、Automation Controller のインスタンスを含むシステムにインストールされるコマンドラインユーティリティーです。

metrics-utility は、インストールおよび設定されると、システムから請求関連のメトリクスを収集し、消費量に基づく請求レポートを作成します。metrics-utility ツールは、管理対象ホストが複数あり、消費量ベースの請求を使用するユーザーに特に適しています。レポートが生成されると、設定ファイルで指定した保存先の場所に保存されます。

metrics-utility は、システムから設定データとレポートデータの 2 種類のデータを収集します。

設定データには次の情報が含まれます。

- Automation Controller とオペレーティングシステムのバージョン情報

- サブスクリプション情報

- ベース URL

レポートデータには次の情報が含まれます。

- ジョブ名と ID

- ホスト名

- インベントリー名

- 組織名

- プロジェクト名

- 成功または失敗に関する情報

- レポート日時

metrics-utility が設定どおりに動作し続けるように、レポートディレクトリーから古いレポートを定期的に消去してください。

12.1. metrics-utility の設定

Red Hat Enterprise Linux と OpenShift Container Platform の両方で、Ansible Automation Platform の使用状況データを収集して報告するように metrics-utility を設定します。

12.1.1. Red Hat Enterprise Linux の metrics-utility の設定

前提条件:

- サブスクリプション: アクティブな Ansible Automation Platform サブスクリプション。

-

インストール:

metrics-utilityツールは、デフォルトで Automation Controller ノード上の Ansible Automation Platform インストールに含まれています。別途インストールする必要はありません。 -

ユーザー権限:

metrics-utilityツールを実行するには、rootユーザーまたはawxユーザーとしてログインしている必要があります。

metrics-utility が正常に機能するには、/etc/tower/SECRET_KEY への読み取りアクセスが必要です。このユーティリティーを標準ユーザー(root または非 awx)として実行しようとすると、PermissionError と実行に失敗します。

次の手順では、関連データを収集し、使用状況メトリクスを含む CCSP レポートを生成します。これらのコマンドを cron ジョブとして設定し、毎月の初めに実行されるようにできます。cron 構文の使用方法の詳細は、How to schedule jobs using the Linux cron utility を参照してください。

手順

metrics-utilityにすべての関連データを収集させるための正しい変数を設定するために、ユーザーのホームディレクトリー内に次の 2 つのスクリプトを作成します。/home/my-user/cron-gather内:Copy to Clipboard Copied! Toggle word wrap Toggle overflow /home/my-user/cron-report内:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

これらのファイルを実行可能にするために、次のコマンドを実行します。

chmod a+x /home/my-user/cron-gather /home/my-user/cron-report編集する

cronファイルを開くには、以下を実行します。crontab -e実行スケジュールを設定するために、ファイルの末尾に次のパラメーターを追加し、

metrics-utilityによって情報を収集してレポートを作成する頻度を cron 構文 を使用して指定します。次の例では、gatherコマンドは毎時 00 分に実行されるように設定されています。build_reportコマンドは、毎月 2 日の午前 4 時に実行されるように設定されています。0 */1 * * * /home/my-user/cron-gather0 4 2 * * /home/my-user/cron-report- ファイルを保存してから閉じます。

検証

正しい設定を確認するには、次の検証手順を使用します。

cronジョブのエントリーが正しく保存されたことを確認するには、次のコマンドを実行します。crontab -l

crontab -lCopy to Clipboard Copied! Toggle word wrap Toggle overflow cronログを調べて、cronデーモンがコマンドを実行し、metrics-utilityが出力を生成していることを確認します。cat /var/log/cron

cat /var/log/cronCopy to Clipboard Copied! Toggle word wrap Toggle overflow 参考までに、次の出力例を参照してください。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 生成されたレポートには、