ブロックデバイスガイド

Red Hat Ceph Storage ブロックデバイスの管理、作成、設定、および使用

概要

第1章 概要

ブロックは、512 バイトのデータブロックなどの一連のバイトです。以下のような回転メディアを使用してデータを保存する最も一般的な方法として、ブロックベースのストレージインターフェイスが挙げられます。

- <hard_disk>

- cds

- フロッピーディスク

- 従来の 9 トラッキングテープにも関わっています。

ブロックデバイスインターフェイスは偏在するので、Red Hat Ceph Storage などのマーシャルデータストレージシステムの操作には仮想ブロックデバイスが理想的です。

Reliable Autonomic Distributed Object Store(RADOS)ブロックデバイス(RBD)とも呼ばれる Ceph ブロックデバイスは、シンプロビジョニングされ、分散可能で、Ceph Storage クラスターの複数の Object Storage Device(OSD)でデータのストライプ化されて保存されます。Ceph ブロックデバイスは、以下のような RADOS 機能を利用します。

- スナップショットの作成

- レプリケーション

- かつ一貫性を保ちます。

Ceph ブロックデバイスは、librbd ライブラリーを使用して OSD と対話します。

Ceph ブロックデバイスは、libvirt ユーティリティーおよび QEMU ユーティリティーに依存して Ceph ブロックデバイスと統合するために、Quick Emulator (QEMU) などの Kernel Virtual Machines (KVM) や OpenStack などのクラウドベースのコンピューティングシステムに、無限のスケーラビリティーと、高いパフォーマンスをもたらします。同じストレージクラスターを使用して、Ceph Object Gateway および Ceph ブロックデバイスを同時に運用できます。

Ceph ブロックデバイスを使用するには、稼働中の Ceph Storage クラスターにアクセスできる必要があります。Red Hat Ceph Storage のインストールに関する詳細は、『 Installation Guide for Red Hat Enterprise Linux or Installation Guide for Ubuntu 』を参照してください。

第2章 ブロックデバイスコマンド

rbd コマンドを使用すると、ブロックデバイスイメージの作成、一覧表示、イントロスペクション、および削除を行うことができます。また、これを使用してイメージのクローン作成、スナップショットの作成、イメージのスナップショットへのロールバック、スナップショットの表示などを行うこともできます。

2.1. 前提条件

Ceph ブロックデバイスと rbd コマンドを使用するには、2 つの前提条件を満たす必要があります。

- 実行中の Ceph Storage クラスターにアクセスできる必要があります。詳細は、『Red Hat Ceph Storage 3 インストールガイド for Red Hat Enterprise Linux 』または『 Installation Guide for Ubuntu 』を参照してください。

- Ceph Block Device クライアントをインストールする必要があります。詳細は、『Red Hat Ceph Storage 3 インストールガイド for Red Hat Enterprise Linux 』または『 Installation Guide for Ubuntu 』を参照してください。

「 Ceph ブロックデバイスの手動インストール」の 章は、クライアントノードでの Ceph ブロックデバイスのマウントおよび使用についても説明します。Ceph Storage クラスターにブロックデバイスのイメージを作成した後にのみ、クライアントノードでこの手順を実施します。詳細は、 を参照してください。

2.2. ヘルプの表示

rbd help コマンドを使用して、特定の rbd コマンドとそのサブコマンドのヘルプを表示します。

rbd help <command> <subcommand>

[root@rbd-client ~]# rbd help <command> <subcommand>例

snap list コマンドのヘルプを表示するには、次のコマンドを実行します。

rbd help snap list

[root@rbd-client ~]# rbd help snap list

-h オプションは引き続き、使用できるすべてのコマンドのヘルプを表示します。

2.3. ブロックデバイスプールの作成

ブロックデバイスクライアントを使用する前に、rbd のプールが存在し、初期化されていることを確認します。rbd プールを作成するには、以下を実行します。

ceph osd pool create {pool-name} {pg-num} {pgp-num}

ceph osd pool application enable {pool-name} rbd

rbd pool init -p {pool-name}

[root@rbd-client ~]# ceph osd pool create {pool-name} {pg-num} {pgp-num}

[root@rbd-client ~]# ceph osd pool application enable {pool-name} rbd

[root@rbd-client ~]# rbd pool init -p {pool-name}最初にプールを作成してから、これをソースとして指定する必要があります。詳細は、Red Hat Ceph Storage ストラテジーガイド の プール の章を参照してください。

2.4. ブロックデバイスイメージの作成

ブロックデバイスをノードに追加する前に、Ceph Storage クラスターにそのイメージを作成します。ブロックデバイスイメージを作成するには、以下のコマンドを実行します。

rbd create <image-name> --size <megabytes> --pool <pool-name>

[root@rbd-client ~]# rbd create <image-name> --size <megabytes> --pool <pool-name>

たとえば、stack という名前のプールに情報を保存する data という名前の 1 GB のイメージを作成するには、以下を実行します。

rbd create data --size 1024 --pool stack

[root@rbd-client ~]# rbd create data --size 1024 --pool stack- 注記

-

イメージを作成する前に

rbdのプールが存在することを確認します。詳細は、「 ブロックデバイスプールの作成 」を参照してください。

2.5. ブロックデバイスイメージの一覧表示

rbd プールのブロックデバイスを一覧表示するには、以下を実行します (rbd はデフォルトのプール名です)。

rbd ls

[root@rbd-client ~]# rbd ls

特定のプールのブロックデバイスを一覧表示するには、以下を実行します。ただし、POOL_NAME はプールの名前に置き換えます。

rbd ls {poolname}

[root@rbd-client ~]# rbd ls {poolname}以下に例を示します。

rbd ls swimmingpool

[root@rbd-client ~]# rbd ls swimmingpool2.6. イメージ情報の取得

特定のイメージから情報を取得するには、以下を実行します。ただし、IMAGE_NAME はイメージの名前に置き換えます。

rbd --image {image-name} info

[root@rbd-client ~]# rbd --image {image-name} info以下に例を示します。

rbd --image foo info

[root@rbd-client ~]# rbd --image foo info

プール内のイメージから情報を取得するには、以下を実行します。ただし、IMAGE_NAME

rbd --image {image-name} -p {pool-name} info

[root@rbd-client ~]# rbd --image {image-name} -p {pool-name} info以下に例を示します。

rbd --image bar -p swimmingpool info

[root@rbd-client ~]# rbd --image bar -p swimmingpool info2.7. ブロックデバイスイメージのサイズ変更

Ceph ブロックデバイスイメージはシンプロビジョニングされています。データの保存を開始する前に、実際には物理ストレージを使用しません。ただし、--size オプションでは、設定する最大容量があります。

Ceph ブロックデバイスイメージの最大サイズを増減するには、以下を実行します。

rbd resize --image <image-name> --size <size>

[root@rbd-client ~]# rbd resize --image <image-name> --size <size>2.8. ブロックデバイスイメージの削除

ブロックデバイスを削除するには以下を実行します。ただし、IMAGE_NAME は削除するイメージの名前に置き換えます。

rbd rm {image-name}

[root@rbd-client ~]# rbd rm {image-name}以下に例を示します。

rbd rm foo

[root@rbd-client ~]# rbd rm foo

プールからブロックデバイスを削除するには以下を実行します。ただし、IMAGE_NAME

rbd rm {image-name} -p {pool-name}

[root@rbd-client ~]# rbd rm {image-name} -p {pool-name}以下に例を示します。

rbd rm bar -p swimmingpool

[root@rbd-client ~]# rbd rm bar -p swimmingpool2.9. ブロックデバイスイメージのゴミ箱への移動

RADOS Block Device (RBD) イメージは、rbd trash コマンドを使用してゴミ箱に移動できます。このコマンドは、rbd rm コマンドよりも多くのオプションがあります。

イメージをゴミ箱に移動すると、後でゴミ箱から取り除くこともできます。この機能により、誤って削除されるのを回避できます。

イメージをゴミ箱に移動するには、以下のコマンドを実行します。

rbd trash move {image-spec}

[root@rbd-client ~]# rbd trash move {image-spec}

イメージがゴミ箱にある場合は、一意のイメージ ID が割り当てられます。ゴミ箱オプションのいずれかを使用する必要がある場合は、後でこのイメージを指定するのにこのイメージ ID が必要です。ゴミ箱にあるイメージ ID の一覧に対して rbd trash list を実行します。このコマンドは、イメージの削除前の名前も返します。

さらに、rbd info および rbd snap コマンドで使用可能な --image-id 引数 (任意) があります。rbd info コマンドに --image-id を使用し、ごみ箱の中にあるイメージのプロパティーを表示し、rbd snap で、イメージのスナップショットをゴミ箱から削除します。

ゴミ箱からのイメージの削除

ゴミ箱からイメージを削除するには、以下のコマンドを実行します。

rbd trash remove [{pool-name}/] {image-id}

[root@rbd-client ~]# rbd trash remove [{pool-name}/] {image-id}イメージがゴミ箱から削除されると、そのイメージは復元できません。

delay Trash removal

--delay オプションを使用して、イメージがゴミ箱から削除されるまでの時間を設定します。以下のコマンドを実行します。{time} は、イメージが削除されるまで待機する秒数に置き換えます(デフォルトは 0)。

rbd trash move [--delay {time}] {image-spec}

[root@rbd-client ~]# rbd trash move [--delay {time}] {image-spec}

--delay オプションを有効にすると、強制されない限り、指定した時間枠内でイメージがゴミ箱から削除できません。

ゴミ箱からのイメージの復元

イメージがゴミ箱から削除されていない限り、rbd trash restore コマンドを使用して復元できます。

rbd trash restore コマンドを実行して、イメージを復元します。

rbd trash restore [{pool-name}/] {image-id}

[root@rbd-client ~]# rbd trash restore [{pool-name}/] {image-id}2.10. イメージ機能の有効化および無効化

既存のイメージでは、fast-diff、exclusive-lock、object-map または journaling などのイメージ機能を有効または無効にできます。

機能を有効にします。

rbd feature enable <pool-name>/<image-name> <feature-name>

[root@rbd-client ~]# rbd feature enable <pool-name>/<image-name> <feature-name>機能を無効にします。

rbd feature disable <pool-name>/<image-name> <feature-name>

[root@rbd-client ~]# rbd feature disable <pool-name>/<image-name> <feature-name>例

dataプールのimage1イメージでexclusive-lock機能を有効にするには、以下を実行します。rbd feature enable data/image1 exclusive-lock

[root@rbd-client ~]# rbd feature enable data/image1 exclusive-lockCopy to Clipboard Copied! Toggle word wrap Toggle overflow dataプールのimage2イメージでfast-diff機能を無効にするには、以下を実行します。rbd feature disable data/image2 fast-diff

[root@rbd-client ~]# rbd feature disable data/image2 fast-diffCopy to Clipboard Copied! Toggle word wrap Toggle overflow

fast-diff および object-map 機能を有効にした後に、オブジェクトマップを再構築します。

rbd object-map rebuild <pool-name>/<image-name>

[root@rbd-client ~]# rbd object-map rebuild <pool-name>/<image-name>

ディープフラット化 機能は、既存のイメージでのみ無効にできますが、有効化できません。ディープフラット化 を使用するには、イメージ作成時に有効化します。

2.11. イメージメタデータの使用

Ceph は、カスタムイメージメタデータをキーと値のペアとして追加することをサポートしています。ペアには厳密な形式がありません。

また、メタデータを使用して、特定のイメージに RBD 設定パラメーターを設定することもできます。詳細は、「 特定のイメージのデフォルト設定の上書き 」を参照してください。

rbd image-meta コマンドを使用して、メタデータと連携します。

イメージメタデータの設定

新しいメタデータのキー/値のペアを設定するには、以下を行います。

rbd image-meta set <pool-name>/<image-name> <key> <value>

[root@rbd-client ~]# rbd image-meta set <pool-name>/<image-name> <key> <value>例

dataプールのdatasetイメージでlast_updateキーを2016-06-06値に設定するには、以下を実行します。rbd image-meta set data/dataset last_update 2016-06-06

[root@rbd-client ~]# rbd image-meta set data/dataset last_update 2016-06-06Copy to Clipboard Copied! Toggle word wrap Toggle overflow

イメージメタデータの削除

メタデータのキー/値のペアを削除するには、以下を実行します。

rbd image-meta remove <pool-name>/<image-name> <key>

[root@rbd-client ~]# rbd image-meta remove <pool-name>/<image-name> <key>例

last_updateのキーと値のペアをデータプールのデータセットイメージから削除するには、以下を実行します。rbd image-meta remove data/dataset last_update

[root@rbd-client ~]# rbd image-meta remove data/dataset last_updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow

キーの値の取得

キーの値を表示するには、次のコマンドを実行します。

rbd image-meta get <pool-name>/<image-name> <key>

[root@rbd-client ~]# rbd image-meta get <pool-name>/<image-name> <key>例

last_updateキーの値を表示するには、次のコマンドを実行します。rbd image-meta get data/dataset last_update

[root@rbd-client ~]# rbd image-meta get data/dataset last_updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow

イメージメタデータの一覧表示

イメージの全メタデータを表示するには、以下のコマンドを実行します。

rbd image-meta list <pool-name>/<image-name>

[root@rbd-client ~]# rbd image-meta list <pool-name>/<image-name>例

データプールのデータを一覧表示するには、以下を実行します。セットイメージに設定されているメタデータrbd data/dataset image-meta list

[root@rbd-client ~]# rbd data/dataset image-meta listCopy to Clipboard Copied! Toggle word wrap Toggle overflow

特定のイメージのデフォルト設定の上書き

特定のイメージについて Ceph 設定ファイルで設定した RBD イメージ設定をオーバーライドするには、conf_ 接頭辞をイメージメタデータとして指定して設定パラメーターを設定します。

rbd image-meta set <pool-name>/<image-name> conf_<parameter> <value>

[root@rbd-client ~]# rbd image-meta set <pool-name>/<image-name> conf_<parameter> <value>例

データプール内のデータセットイメージの RBD キャッシュを無効にするには、以下を実行します。rbd image-meta set data/dataset conf_rbd_cache false

[root@rbd-client ~]# rbd image-meta set data/dataset conf_rbd_cache falseCopy to Clipboard Copied! Toggle word wrap Toggle overflow

可能な設定オプションの一覧は、「 ブロックデバイスの設定リファレンス 」を参照してください。

第3章 スナップショット

スナップショットは、特定の時点におけるイメージの状態の読み取り専用コピーです。Ceph ブロックデバイスの高度な機能の 1 つとして、イメージのスナップショットを作成して、イメージの状態の履歴を保持できることが挙げられます。また、Ceph はスナップショットの階層化もサポートしており、イメージ(VM イメージなど)のクローンを迅速かつ簡単に作成することができます。Ceph は、QEMU、libvirt、OpenStack、および CloudStack など、rbd コマンドと、より上層レベルのインターフェイスを使用するブロックデバイススナップショットをサポートします。

RBD スナップショットを使用するには、Ceph クラスターが稼働中である必要があります。

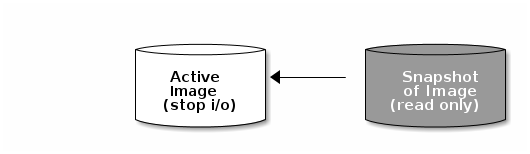

I/O がイメージの進行中にスナップショットを作成する場合は、スナップショットがイメージの正確なデータまたは最新データを取得せず、マウントを可能にするためにスナップショットのクローンを作成する必要がある場合があります。そのため、イメージのスナップショットを作成する前に、I/O を停止することが推奨されます。イメージにファイルシステムが含まれる場合に、ファイルシステムはスナップショットの作成前に整合性のある状態でなければなりません。I/O を停止するには、fsfreeze コマンドを使用します。詳細は、 fsfreeze(8) の man ページを参照してください。仮想マシンの場合には、qemu-guest-agent を使用してスナップショットの作成時にファイルシステムを自動的にフリーズできます。

3.1. cephx に関する注意

cephx が有効な場合には、ユーザー名または ID とユーザーに対応するキーが含まれるキーリングへのパスを指定する必要があります。以下のパラメーターのエントリーを再追加しなくてもいいように、CEPH_ARGS 環境変数を追加することもできます。

rbd --id {user-ID} --keyring=/path/to/secret [commands]

rbd --name {username} --keyring=/path/to/secret [commands]

[root@rbd-client ~]# rbd --id {user-ID} --keyring=/path/to/secret [commands]

[root@rbd-client ~]# rbd --name {username} --keyring=/path/to/secret [commands]以下に例を示します。

rbd --id admin --keyring=/etc/ceph/ceph.keyring [commands] rbd --name client.admin --keyring=/etc/ceph/ceph.keyring [commands]

[root@rbd-client ~]# rbd --id admin --keyring=/etc/ceph/ceph.keyring [commands]

[root@rbd-client ~]# rbd --name client.admin --keyring=/etc/ceph/ceph.keyring [commands]

ユーザーとシークレットを CEPH_ARGS 環境変数に追加して、毎回入力する必要がないようにします。

3.2. スナップショットの基本

以下の手順では、コマンドラインで rbd コマンドを使用して、スナップショットを作成、一覧表示、および削除する方法を説明します。

3.2.1. スナップショットの作成

rbd でスナップショットを作成するには、snap create オプション、プール名、およびイメージ名を指定します。

rbd --pool {pool-name} snap create --snap {snap-name} {image-name}

rbd snap create {pool-name}/{image-name}@{snap-name}

[root@rbd-client ~]# rbd --pool {pool-name} snap create --snap {snap-name} {image-name}

[root@rbd-client ~]# rbd snap create {pool-name}/{image-name}@{snap-name}以下に例を示します。

rbd --pool rbd snap create --snap snapname foo rbd snap create rbd/foo@snapname

[root@rbd-client ~]# rbd --pool rbd snap create --snap snapname foo

[root@rbd-client ~]# rbd snap create rbd/foo@snapname3.2.2. スナップショットの一覧表示

イメージのスナップショットを一覧表示するには、プール名とイメージ名を指定します。

rbd --pool {pool-name} snap ls {image-name}

rbd snap ls {pool-name}/{image-name}

[root@rbd-client ~]# rbd --pool {pool-name} snap ls {image-name}

[root@rbd-client ~]# rbd snap ls {pool-name}/{image-name}以下に例を示します。

rbd --pool rbd snap ls foo rbd snap ls rbd/foo

[root@rbd-client ~]# rbd --pool rbd snap ls foo

[root@rbd-client ~]# rbd snap ls rbd/foo3.2.3. スナップショットのロールバック

rbd を使用してスナップショットにロールバックするには、snap rollback オプション、プール名、イメージ名、および snap 名を指定します。

rbd --pool {pool-name} snap rollback --snap {snap-name} {image-name}

rbd snap rollback {pool-name}/{image-name}@{snap-name}

rbd --pool {pool-name} snap rollback --snap {snap-name} {image-name}

rbd snap rollback {pool-name}/{image-name}@{snap-name}以下に例を示します。

rbd --pool rbd snap rollback --snap snapname foo rbd snap rollback rbd/foo@snapname

rbd --pool rbd snap rollback --snap snapname foo

rbd snap rollback rbd/foo@snapnameイメージをスナップショットにロールバックすると、イメージの現行バージョンがスナップショットからのデータで上書きされます。ロールバックの実行にかかる時間は、イメージのサイズとともに増加します。スナップショットにイメージを ロールバック するよりも、クローンするほうが短時間ででき、既存の状態戻す方法として推奨の方法です。

3.2.4. スナップショットの削除

rbd でスナップショットを削除するには、snap rm オプション、プール名、イメージ名、およびスナップショット名を指定します。

rbd --pool <pool-name> snap rm --snap <snap-name> <image-name> rbd snap rm <pool-name-/<image-name>@<snap-name>

[root@rbd-client ~]# rbd --pool <pool-name> snap rm --snap <snap-name> <image-name>

[root@rbd-client ~]# rbd snap rm <pool-name-/<image-name>@<snap-name>以下に例を示します。

rbd --pool rbd snap rm --snap snapname foo rbd snap rm rbd/foo@snapname

[root@rbd-client ~]# rbd --pool rbd snap rm --snap snapname foo

[root@rbd-client ~]# rbd snap rm rbd/foo@snapnameイメージにクローンがある場合には、クローン作成されたイメージは、親イメージのスナップショットへの参照を保持します。親イメージのスナップショットを削除するには、最初に子イメージをフラット化する必要があります。詳細は、「クローン作成されたイメージの追加 」を参照してください。

Ceph OSD デーモンはデータを非同期的に削除するため、スナップショットを削除してもディスク領域がすぐに解放されません。

3.2.5. スナップショットのパージ

rbd でイメージのすべてのスナップショットを削除するには、snap purge オプションとイメージ名を指定します。

rbd --pool {pool-name} snap purge {image-name}

rbd snap purge {pool-name}/{image-name}

[root@rbd-client ~]# rbd --pool {pool-name} snap purge {image-name}

[root@rbd-client ~]# rbd snap purge {pool-name}/{image-name}以下に例を示します。

rbd --pool rbd snap purge foo rbd snap purge rbd/foo

[root@rbd-client ~]# rbd --pool rbd snap purge foo

[root@rbd-client ~]# rbd snap purge rbd/foo3.2.6. スナップショットの名前変更

スナップショットの名前を変更するには、以下のコマンドを実行します。

rbd snap rename <pool-name>/<image-name>@<original-snapshot-name> <pool-name>/<image-name>@<new-snapshot-name>

[root@rbd-client ~]# rbd snap rename <pool-name>/<image-name>@<original-snapshot-name> <pool-name>/<image-name>@<new-snapshot-name>例

データ プールの dataset イメージの snap1 スナップショットの名前を snap2 に変更するには、以下を実行します。

rbd snap rename data/dataset@snap1 data/dataset@snap2

[root@rbd-client ~]# rbd snap rename data/dataset@snap1 data/dataset@snap2

rbd help snap rename コマンドを実行して、スナップショットの名前変更に関する追加情報を表示します。

3.3. layering

Ceph は、ブロックデバイススナップショットの多数のコピーオンライト (COW) またはコピーオンリード (COR) のクローンを作成する機能をサポートしています。スナップショットの階層化により、Ceph ブロックデバイスクライアントはイメージを非常に迅速に作成できます。たとえば、Linux 仮想マシンに書き込まれた Linux 仮想マシンを使用してブロックデバイスイメージを作成し、そのイメージをスナップショットを作成してスナップショットを保護し、必要に応じてクローンを作成します。スナップショットは読み取り専用であるため、スナップショットのクローンを作成するとセマンティクスが簡素化され、クローンの作成時間を短縮できます。

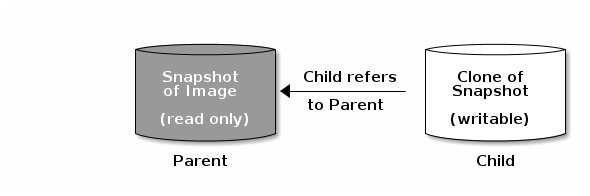

親 および 子 という用語は、Ceph ブロックデバイスのスナップショット (親)、およびスナップショットからクローン作成された対応のイメージ (子) を意味します。以下のコマンドラインを使用する場合に、これらの用語が重要です。

クローン作成された各イメージ (子) は、親イメージへの参照を保存し、クローン作成されたイメージで親スナップショットを開き、読み取ることができるようになります。この参照は、クローンが フラット化 (スナップショットからの情報が完全にクローンにコピー) されると、削除されます。フラット化の詳細は、「クローンしたイメージのフラット化」 を 参照 してください。

スナップショットのクローン作成は、他の Ceph ブロックデバイスイメージのように動作します。クローン作成されたイメージを読み取り、書き込み、クローンし、サイズを変更できます。クローン作成されたイメージには、特別な制限はありません。ただし、スナップショットのクローンはスナップショットを参照するので、クローンを作成する前にスナップショットを保護する 必要があります。

スナップショットのクローンは、コピーオンライト (COW) またはコピーオンリード (COR) のいずれかです。クローンではコピーオンライト (COW) は常に有効で、コピーオンリード (COR) は明示的に有効化する必要があります。コピーオンライト (COW) は、クローン内の未割り当てのオブジェクトへの書き込み時に、親からクローンにデータをコピーします。コピーオンリード (COR) は、クローン内の未割り当てのオブジェクトから読み取る時に、親からクローンにデータをコピーします。クローンからデータの読み取りは、オブジェクトがクローンに存在しない場合、親からのデータのみを読み取ります。RADOS ブロックデバイスでは、大規模なイメージを複数のオブジェクトに分割し(デフォルトは 4 MB)、すべてのコピーオンライト(COW)および Copy-on-read(COR)操作が完全なオブジェクト(つまり 1 バイトをクローンに書き込む)で行われます(つまり、クローンに 1 バイトを書き込む)、宛先オブジェクトが親から読み取られ、以前の COW/COR 操作からクローンに存在しない場合は、クローンに書き込まれます。

コピーオンリード (COR) が有効になっているかどうか。クローンから下層にあるオブジェクトを読み取ることができない場合には、親に再ルーティングされます。実質的に親の数に制限が特にないため、クローンのクローンを作成できます。これは、オブジェクトが見つかるまで、またはベースの親イメージに到達するまで、この再ルーティングが続行されます。コピーオンリード (COR) が有効になっている場合には、クローンから直接読み取ることができない場合には、親からすべてのオブジェクトを読み取り、そのデータをクローンに書き込むことで、今後、親から読み取る必要なく、同じエクステントの読み取りがクローン自体で行われるようにします。

これは基本的に、オンデマンドのオブジェクトごとのフラット化操作です。これは、クローンが親から離れた高遅延接続の場所 (別の地理的場所の別のプールにある親など) にある場合に特に便利です。コピーオンリード (COR) では、読み取りのならし遅延が短縮されます。最初の数回読み取りは、親から追加のデータが読み取られるため、レイテンシーが高くなっています。たとえば、クローンから 1 バイトを読み取る場合に、4 MB を親から読み取り、クローンに書き込みする必要がありますが、それ以降はクローン自体からすべての読み取りが行われます。

スナップショットからコピーオンリード (COR) のクローンを作成するには、ceph.conf ファイルの [global] セクションまたは [client] セクションに rbd_clone_copy_on_read = true を追加してこの機能を明示的に有効にする必要があります。

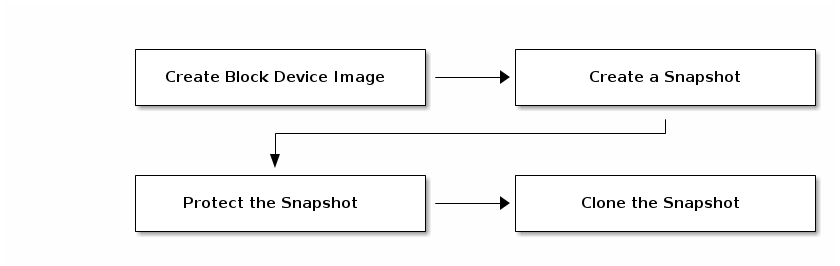

3.3.1. レイヤーの使用開始

Ceph ブロックデバイスの階層化は単純なプロセスです。イメージが必要です。イメージのスナップショットを作成する必要があります。スナップショットを保護する必要があります。これらの手順を実行すると、スナップショットのクローン作成を開始できます。

クローン作成されたイメージには、親スナップショットへの参照があり、プール ID、イメージ ID、およびスナップショット ID が含まれます。プール ID が含まれると、あるプールから別のプールにスナップショットのクローンを作成できます。

-

イメージテンプレート: ブロックデバイスの階層化における一般的なユースケースとして、マスターイメージと、クローンのテンプレートとして機能するスナップショットが作成されます。たとえば、RHEL7 ディストリビューションのイメージを作成して、そのスナップショットを作成できます。定期的に、ユーザーはイメージを更新して新規スナップショットを作成することができます(

yum update、yum upgrade、rbd snap createなど)。イメージが成熟すると、ユーザーはスナップショットのいずれかのクローンを作成できます。 - 拡張テンプレート: より高度なユースケースには、ベースイメージよりも多くの情報を提供するテンプレートイメージの拡張が含まれます。たとえば、ユーザーはイメージのクローンを作成し(仮想マシンテンプレートなど)、他のソフトウェア(データベース、コンテンツ管理システム、解析システムなど)をインストールし、ベースイメージと同様に更新できる拡張イメージをスナップショットできます。

- テンプレートプール: ブロックデバイスの階層化を使用する方法は、テンプレートとして機能するマスターイメージを含むプールと、それらのテンプレートのスナップショットを作成することです。その後、ユーザーに読み取り専用の権限を拡張して、プール内で読み書きや実行を実行せずにスナップショットのクローンを作成できます。

- イメージの移行/リカバリー: ブロックデバイスの階層化を使用する方法は、あるプールから別のプールにデータを移行または復元することです。

3.3.2. スナップショットの保護

親スナップショットのクローン作成は、親スナップショットにアクセスします。ユーザーが親のスナップショットを誤って削除した場合に、クローンはすべて破損します。データの損失を防ぐには、クローンを作成する前にスナップショットを保護する 必要 があります。これには以下のコマンドを実行します。

rbd --pool {pool-name} snap protect --image {image-name} --snap {snapshot-name}

rbd snap protect {pool-name}/{image-name}@{snapshot-name}

[root@rbd-client ~]# rbd --pool {pool-name} snap protect --image {image-name} --snap {snapshot-name}

[root@rbd-client ~]# rbd snap protect {pool-name}/{image-name}@{snapshot-name}以下に例を示します。

rbd --pool rbd snap protect --image my-image --snap my-snapshot rbd snap protect rbd/my-image@my-snapshot

[root@rbd-client ~]# rbd --pool rbd snap protect --image my-image --snap my-snapshot

[root@rbd-client ~]# rbd snap protect rbd/my-image@my-snapshot保護されたスナップショットは削除できません。

3.3.3. スナップショットのクローン作成

スナップショットのクローンを作成するには、親プール、イメージ、スナップショット、および子プールおよびイメージ名を指定する必要があります。スナップショットのクローンを作成する前に、スナップショットを保護する必要があります。これには以下のコマンドを実行します。

rbd --pool {pool-name} --image {parent-image} --snap {snap-name} --dest-pool {pool-name} --dest {child-image}

rbd clone {pool-name}/{parent-image}@{snap-name} {pool-name}/{child-image-name}

[root@rbd-client ~]# rbd --pool {pool-name} --image {parent-image} --snap {snap-name} --dest-pool {pool-name} --dest {child-image}

[root@rbd-client ~]# rbd clone {pool-name}/{parent-image}@{snap-name} {pool-name}/{child-image-name}以下に例を示します。

rbd clone rbd/my-image@my-snapshot rbd/new-image

[root@rbd-client ~]# rbd clone rbd/my-image@my-snapshot rbd/new-imageスナップショットは、あるプールから別のプールのイメージにクローンできます。たとえば、読み取り専用のイメージやスナップショットを 1 つのプール内のテンプレートとして維持し、別のプール内の書き込み可能なクローンとして維持することができます。

3.3.4. スナップショットの保護解除

スナップショットを削除する前に、そのスナップショットを保護解除する必要があります。さらに、クローンからの参照があるスナップショットは、削除できません。スナップショットを削除する前に、スナップショットの各クローンをフラット化する必要があります。これには以下のコマンドを実行します。

rbd --pool {pool-name} snap unprotect --image {image-name} --snap {snapshot-name}

rbd snap unprotect {pool-name}/{image-name}@{snapshot-name}

[root@rbd-client ~]#rbd --pool {pool-name} snap unprotect --image {image-name} --snap {snapshot-name}

[root@rbd-client ~]# rbd snap unprotect {pool-name}/{image-name}@{snapshot-name}以下に例を示します。

rbd --pool rbd snap unprotect --image my-image --snap my-snapshot rbd snap unprotect rbd/my-image@my-snapshot

[root@rbd-client ~]# rbd --pool rbd snap unprotect --image my-image --snap my-snapshot

[root@rbd-client ~]# rbd snap unprotect rbd/my-image@my-snapshot3.3.5. スナップショットの子の一覧表示

スナップショットの子を一覧表示するには、以下のコマンドを実行します。

rbd --pool {pool-name} children --image {image-name} --snap {snap-name}

rbd children {pool-name}/{image-name}@{snapshot-name}

rbd --pool {pool-name} children --image {image-name} --snap {snap-name}

rbd children {pool-name}/{image-name}@{snapshot-name}以下に例を示します。

rbd --pool rbd children --image my-image --snap my-snapshot rbd children rbd/my-image@my-snapshot

rbd --pool rbd children --image my-image --snap my-snapshot

rbd children rbd/my-image@my-snapshot3.3.6. クローンしたイメージのフラット化

クローン作成されたイメージは、親スナップショットへの参照を保持します。子クローンから親スナップショットに参照を削除すると、スナップショットからクローンに情報をコピーして、イメージを効果的に「フラット化」します。スナップショットのサイズでクローンのフラット化にかかる時間が増加します。

子イメージに関連付けられた親イメージのスナップショットを削除するには、最初に子イメージをフラット化する必要があります。

rbd --pool <pool-name> flatten --image <image-name> rbd flatten <pool-name>/<image-name>

[root@rbd-client ~]# rbd --pool <pool-name> flatten --image <image-name>

[root@rbd-client ~]# rbd flatten <pool-name>/<image-name>以下に例を示します。

rbd --pool rbd flatten --image my-image rbd flatten rbd/my-image

[root@rbd-client ~]# rbd --pool rbd flatten --image my-image

[root@rbd-client ~]# rbd flatten rbd/my-imageフラット化イメージにはスナップショットからのすべての情報が含まれるため、フラット化されるイメージは階層化されたクローンよりも多くのストレージ領域を使用します。

イメージで ディープフラット 機能が有効になっている場合には、イメージのクローンは、デフォルトで親から分離されます。

第4章 ブロックデバイスのミラーリング

RADOS Block Device (RBD) ミラーリングとは、2 つ以上の Ceph Storage クラスター間で Ceph ブロックデバイスイメージを非同期にレプリケーションするプロセスのことです。ミラーリングには次の利点があります。* 読み取りと書き込み、ブロックデバイスのサイズ変更、スナップショット、クローン、およびフラット化を含む、イメージに対するすべての変更のポイントインタイムの一貫したレプリカを確保します。

ミラーリングは、必須の排他的ロックと RBD ジャーナリング機能を使用して、すべての変更をイメージに対して発生する順序で記録します。これにより、イメージのクラッシュ整合性のあるミラーが利用できるようになりました。イメージをピアクラスターにミラーリングする前に、ジャーナリングを有効にする必要があります。詳細は、「ジャーナルの有効化」 を参照してください。

これはミラーリングされるブロックデバイスに関連付けられたプライマリーおよびセカンダリープールに保存されるイメージであるため、プライマリープールおよびセカンダリープールの CRUSH 階層には、同じストレージ容量とパフォーマンスの特性が必要です。さらに、プライマリーサイトとセカンダリーサイト間のネットワーク接続には、十分な帯域幅を確保して、ミラーリングがレイテンシーが大きくなりすぎないようにする必要があります。

ブロックデバイスイメージをミラーリングするプライマリーおよびセカンダリープールに対応する CRUSH 階層には、容量とパフォーマンスの特性が同じである必要があり、また、追加のレイテンシーなしにミラーリングを行うために十分な帯域幅が必要になります。たとえば、プライマリークラスター内のイメージへの平均書き込みスループットが X MiB/s である場合に、ネットワークはセカンダリーサイトへのネットワーク接続で N * X スループットと、N イメージをミラーリングする安全係数 Y% に対応している必要があります。

ミラーリングは、主に障害からのリカバリーに対応します。使用しているミラーリングのタイプに応じて、一方向ミラーリングを使用した障害からの復旧 または 双方向ミラーリングを使用した障害からの復旧 を参照してください。

rbd-mirror デーモン

rbd-mirror デーモンは、ある Ceph クラスターから別のクラスターへのイメージの同期を担当します。

レプリケーションのタイプに応じて、rbd-mirror は単一のクラスターまたはミラーリングに参加するすべてのクラスターで実行されます。

一方向レプリケーション

-

データがプライマリークラスターからバックアップとして機能するセカンダリークラスターにミラーリングされる場合、

rbd-mirrorはバックアップクラスターでのみ実行されます。RBD ミラーリングには複数のセカンダリーサイトがある場合があります。

-

データがプライマリークラスターからバックアップとして機能するセカンダリークラスターにミラーリングされる場合、

双方向レプリケーション

-

双方向レプリケーションは、プライマリークラスターに

rbd-mirrorデーモンを追加して、そのクラスターでイメージをデモートし、セカンダリークラスターでプロモートできるようにします。その後、セカンダリークラスターのイメージに対して変更が行われ、セカンダリーからプライマリーに逆方向にレプリケートされます。どちらかのクラスターでのイメージのプロモートとデモートを可能にするには、両方のクラスターでrbd-mirrorが実行されている必要があります。現在、双方向レプリケーションは 2 つのサイトの間でのみサポートされています。

-

双方向レプリケーションは、プライマリークラスターに

rbd-mirror パッケージは、rbd-mirror を提供します。

双方向レプリケーションでは、rbd-mirror の各インスタンスが同時に他の Ceph クラスターに接続できる必要があります。また、ミラーリングを処理するために、ネットワークには 2 つのデータセンターサイトの間で十分な帯域幅が必要です。

Ceph クラスターごとに単一の rbd-mirror デーモンのみを実行します。

ミラーリングモード

ミラーリングは、ピアクラスター内のプールごとに設定されます。Ceph は、プールのミラーリングするイメージに応じて、2 つのモードをサポートします。

- プールモード

- ジャーナリング機能が有効になっているプール内のイメージはすべてミラーリングされます。詳細は、プールミラーリングの設定 を参照してください。

- イメージモード

- プール内のイメージの特定のサブセットのみがミラーリングされるため、イメージごとにミラーリングを個別に有効にする必要があります。詳細は、イメージのミラーリングの設定 を参照してください。

イメージの状態

イメージの変更が可能かどうかは、その状態により異なります。

- プライマリー状態のイメージを変更できます。

- プライマリー状態以外のイメージは変更できません。

イメージでミラーリングが最初に有効化された時点で、イメージはプライマリーに自動的にプロモートされます。以下でプロモートが可能です。

- プールモードでミラーリングを暗黙的に有効にする。

- 特定のイメージのミラーリングを明示的に有効にする。

プライマリーイメージをデモートし、プライマリー以外のイメージをプロモートすることができます。詳細は、「イメージ設定」 を参照してください。

4.1. ジャーナルの有効化

RBD ジャーナリング機能を有効にできます。

- イメージが作成されたとき

- 既存のイメージに対して動的に。

ジャーナリングは、有効にする必要がある exclusive-lock 機能に依存します。以下の手順を参照してください。

イメージの作成時にジャーナリングを有効にするには、--image-feature オプションを使用します。

rbd create <image-name> --size <megabytes> --pool <pool-name> --image-feature <feature>

rbd create <image-name> --size <megabytes> --pool <pool-name> --image-feature <feature>以下に例を示します。

rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journaling

# rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journaling

以前に作成したイメージでジャーナリングを有効にするには、rbd feature enable コマンドを使用します。

rbd feature enable <pool-name>/<image-name> <feature-name>

rbd feature enable <pool-name>/<image-name> <feature-name>以下に例を示します。

rbd feature enable data/image1 exclusive-lock rbd feature enable data/image1 journaling

# rbd feature enable data/image1 exclusive-lock

# rbd feature enable data/image1 journalingデフォルトですべての新規イメージのジャーナリングを有効にするには、以下の設定を Ceph 設定ファイルに追加します。

rbd default features = 125

rbd default features = 1254.2. プール設定

本章では、以下のタスクを実行する方法を説明します。

- プールでのミラーリングの有効化

- プールでのミラーリングの無効化

- クラスターピアの追加

- ピアに関する情報の表示

- クラスターピアの削除

- プールのミラーリングステータスの取得

両方のピアクラスターで以下のコマンドを実行します。

プールでのミラーリングの有効化

プールのミラーリングを有効にするには、以下を実行します。

rbd mirror pool enable <pool-name> <mode>

rbd mirror pool enable <pool-name> <mode>例

data という名前のプール全体のミラーリングを有効にするには、以下を実行します。

rbd mirror pool enable data pool

# rbd mirror pool enable data pool

data という名前のプールでイメージモードのミラーリングを有効にするには、以下を実行します。

rbd mirror pool enable data image

# rbd mirror pool enable data image詳細は、「 Mirroring Modes 」を参照してください。

プールでのミラーリングの無効化

プールのミラーリングを無効にするには、以下を実行します。

rbd mirror pool disable <pool-name>

rbd mirror pool disable <pool-name>例

data という名前のプールのミラーリングを無効にするには、以下を実行します。

rbd mirror pool disable data

# rbd mirror pool disable dataミラーリングを無効にする前に、ピアクラスターを削除します。詳細は、「プール設定」 を参照してください。

プールのミラーリングを無効にすると、ミラーリングを別に有効化していたプール内にあるイメージに対するミラーリングも無効化されます。詳細は イメージ設定 を参照してください。

クラスターピアの追加

rbd-mirror デーモンがそのピアクラスターを検出するには、ピアをプールに登録する必要があります。

rbd --cluster <cluster-name> mirror pool peer add <pool-name> <peer-client-name>@<peer-cluster-name> -n <client-name>

rbd --cluster <cluster-name> mirror pool peer add <pool-name> <peer-client-name>@<peer-cluster-name> -n <client-name>例

site-a クラスターをピアとして site-b クラスターに追加するには、site-b クラスターのクライアントノードから以下のコマンドを実行します。

rbd --cluster site-b mirror pool peer add data client.site-a@site-a -n client.site-b

# rbd --cluster site-b mirror pool peer add data client.site-a@site-a -n client.site-bピアに関する情報の表示

ピアの情報を表示するには、以下を実行します。

rbd mirror pool info <pool-name>

rbd mirror pool info <pool-name>例

rbd mirror pool info data Mode: pool Peers: UUID NAME CLIENT 7e90b4ce-e36d-4f07-8cbc-42050896825d site-a client.site-a

# rbd mirror pool info data

Mode: pool

Peers:

UUID NAME CLIENT

7e90b4ce-e36d-4f07-8cbc-42050896825d site-a client.site-aクラスターピアの削除

ミラーリングピアクラスターを削除するには、以下を実行します。

rbd mirror pool peer remove <pool-name> <peer-uuid>

rbd mirror pool peer remove <pool-name> <peer-uuid>

プール名とピア一意識別子 (UUID) を指定します。ピア UUID を表示するには、rbd mirror pool info コマンドを使用します。

例

rbd mirror pool peer remove data 7e90b4ce-e36d-4f07-8cbc-42050896825d

# rbd mirror pool peer remove data 7e90b4ce-e36d-4f07-8cbc-42050896825dプールのミラーリングステータスの取得

ミラーリングプールの概要を取得するには、以下を実行します。

rbd mirror pool status <pool-name>

rbd mirror pool status <pool-name>例

データ プールのステータスを取得するには、以下を実行します。

rbd mirror pool status data health: OK images: 1 total

# rbd mirror pool status data

health: OK

images: 1 total

プールのすべてのミラーリングイメージのステータス詳細を出力するには、--verbose オプションを使用します。

4.3. イメージ設定

本章では、以下のタスクを実行する方法を説明します。

- イメージミラーリングの有効化

- イメージミラーリングの無効化

- イメージのプロモートおよびデモート

- イメージの再同期

- 単一イメージのミラーリングステータスの取得

単一クラスターでのみ以下のコマンドを実行します。

イメージミラーリングの有効化

特定のイメージのミラーリングを有効にするには、以下を実行します。

- 両方のピアクラスターでプール全体のミラーリングを有効にします。詳細は、「プール設定」 を参照してください。

次に、プール内の特定イメージのミラーリングを明示的に有効にします。

rbd mirror image enable <pool-name>/<image-name>

rbd mirror image enable <pool-name>/<image-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

例

データ プールの image 2 イメージ のミラーリングを有効にするには、以下を実行します。

rbd mirror image enable data/image2

# rbd mirror image enable data/image2イメージミラーリングの無効化

特定のイメージのミラーリングを無効にするには、以下を実行します。

rbd mirror image disable <pool-name>/<image-name>

rbd mirror image disable <pool-name>/<image-name>例

データ プールの image 2 イメージ のミラーリングを無効にするには、以下を実行します。

rbd mirror image disable data/image2

# rbd mirror image disable data/image2イメージのプロモートおよびデモート

プライマリー以外にイメージをデモートするには、以下のコマンドを実行します。

rbd mirror image demote <pool-name>/<image-name>

rbd mirror image demote <pool-name>/<image-name>例

データ プールの image 2 イメージ を降格するには、以下を実行します。

rbd mirror image demote data/image2

# rbd mirror image demote data/image2イメージをプライマリーにプロモートするには、以下のコマンドを実行します。

rbd mirror image promote <pool-name>/<image-name>

rbd mirror image promote <pool-name>/<image-name>例

データ プールの image 2 イメージ をプロモートするには、以下を実行します。

rbd mirror image promote data/image2

# rbd mirror image promote data/image2使用しているミラーリングのタイプに応じて、一方向ミラーリングを使用した障害からの復旧 または 双方向ミラーリングを使用した障害からの復旧 を参照してください。

--force オプションを使用して、プライマリー以外のイメージを強制的にプロモートします。

rbd mirror image promote --force data/image2

# rbd mirror image promote --force data/image2クラスターの障害や通信の停止などの理由により、降格がピア Ceph クラスターに伝播できない場合、強制的なプロモートを使用します。詳細は、正常にシャットダウンされなかった場合のフェイルオーバー を参照してください。

プロモート後にイメージは有効にならないので、プライマリー以外の同期中のイメージを強制的にプロモートしないでください。

イメージの再同期

プライマリーイメージに再同期を要求するには、以下を実行します。

rbd mirror image resync <pool-name>/<image-name>

rbd mirror image resync <pool-name>/<image-name>例

データ プール内の image 2 イメージ の再同期を要求するには、以下を実行します。

rbd mirror image resync data/image2

# rbd mirror image resync data/image2

2 つのピアクラスターの間で整合性がない状態の場合に、rbd-mirror デーモンは、不整合の原因となるイメージのミラーリングは試行しません。この問題を修正する方法は、「障害からの復旧」セクションを参照してください。使用しているミラーリングのタイプに応じて、一方向ミラーリングを使用した障害からの復旧 または 双方向ミラーリングを使用した障害からの復旧 を参照してください。

単一イメージのミラーリングステータスの取得

ミラーリングされたイメージのステータスを取得するには、以下を実行します。

rbd mirror image status <pool-name>/<image-name>

rbd mirror image status <pool-name>/<image-name>例

データ プールの image 2 イメージ のステータスを取得するには、以下を実行します。

4.4. 1-Way ミラーリングの設定

一方向ミラーリングは、1 つのクラスターのプライマリーイメージがセカンダリークラスターに複製されることを意味します。セカンダリークラスターでは、複製されたイメージはプライマリーではありません。つまり、ブロックデバイスクライアントはイメージに書き込みできません。

一方向ミラーリングは、複数のセカンダリーサイトをサポートします。複数のセカンダリーサイトで一方向ミラーリングを設定するには、各セカンダリークラスターで以下の手順を繰り返します。

一方向ミラーリングは、イメージのクラッシュコンバーストコピーを維持するのに適しています。一方向ミラーリングは、一方向ミラーリングの使用時にクラスターがフェイルバックできないため、OpenStack でセカンダリーイメージを使用し、OpenStack でフェイルバックするなど、すべての状況には適さない場合があります。このようなシナリオでは、双方向ミラーリングを使用します。詳細は、「2 つのWay Mirroring の設定」 を参照してください。

以下の手順では、以下を前提としています。

-

2 つのクラスターがあり、プライマリークラスターからセカンダリークラスターにイメージを複製する必要があります。この手順では、プライマリーイメージを

site-aクラスター、およびイメージをsite-bクラスターとして複製するクラスターを参照して、2 つのクラスターを区別します。Ceph Storage クラスターのインストールに関する情報は、『 Installation Guide for Red Hat Enterprise Linux 』または『 Installation Guide for Ubuntu 』を参照してください。 -

site-bクラスターには、rbd-mirrorデーモンが実行されるクライアントノードが割り当てられます。このデーモンはsite-aクラスターに接続し、イメージをsite-bクラスターに同期します。Ceph クライアントのインストールに関する情報は、『 Installation Guide for Red Hat Enterprise Linux 』または「 Installation Guide for Ubuntu」を参照してください。 -

両方のクラスターに同じ名前を持つプールが作成されます。以下の例では、プールの名前は

dataです。詳細は、『 Storage Strategies Guide 』の「 Pools 」または「Red Hat Ceph Storage 3」の章を参照してください。 -

プールにはミラーリングするイメージが含まれ、ジャーナリングを有効にしておく。以下の例では、イメージの名前は

image1およびimage2です。詳細は、「 ジャーナルの有効化 」を参照してください。

ブロックデバイスのミラーリングを設定する方法は 2 つあります。

- プール のミラー リング: プール内のすべてのイメージをミラーリングするには、「プールミラーリング の設定」の手順を使用します。

- イメージ のミラー リング: プール内のイメージを反映させるには、「イメージミラーリング の設定」の手順を使用します。

プールミラーリングの設定

-

データプール内のすべてのイメージが排他的ロックを持ち、ジャーナリングが有効になっていることを確認します。詳細は、 を参照してください。 site-bクラスターのクライアントノードで、rbd-mirrorパッケージをインストールします。パッケージは Red Hat Ceph Storage Tools リポジトリーによって提供されます。Red Hat Enterprise Linux

yum install rbd-mirror

# yum install rbd-mirrorCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ubuntu

sudo apt-get install rbd-mirror

$ sudo apt-get install rbd-mirrorCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-bクラスターのクライアントノードで、CLUSTERオプションを適切なファイルに追加してクラスター名を指定します。Red Hat Enterprise Linux で、/etc/sysconfig/cephファイルを更新し、Ubuntu で、それに応じて/etc/default/cephファイルを更新します。CLUSTER=site-b

CLUSTER=site-bCopy to Clipboard Copied! Toggle word wrap Toggle overflow 両方のクラスターで、

データプールにアクセスしてキーリングを <cluster-name>.client.<user-name>.keyring ファイルに出力するパーミッションを持つユーザーを作成します。site-aクラスターのモニターホストで、client.site-aユーザーを作成し、キーリングをsite-a.client.site-a.keyringファイルに出力します。ceph auth get-or-create client.site-a mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/site-a.client.site-a.keyring

# ceph auth get-or-create client.site-a mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/site-a.client.site-a.keyringCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-bクラスターのモニターホストで、client.site-bユーザーを作成し、キーリングをsite-b.client.site-b.keyringファイルに出力します。ceph auth get-or-create client.site-b mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/site-b.client.site-b.keyring

# ceph auth get-or-create client.site-b mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/site-b.client.site-b.keyringCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Ceph 設定ファイルおよび新たに作成された鍵ファイルを

site-aのモニターノードからsite-bのモニターおよびクライアントノードにコピーします。scp /etc/ceph/ceph.conf <user>@<site-b_mon-host-name>:/etc/ceph/site-a.conf scp /etc/ceph/site-a.client.site-a.keyring <user>@<site-b_mon-host-name>:/etc/ceph/ scp /etc/ceph/ceph.conf <user>@<site-b_client-host-name>:/etc/ceph/site-a.conf scp /etc/ceph/site-a.client.site-a.keyring <user>@<site-b_client-host-name>:/etc/ceph/

# scp /etc/ceph/ceph.conf <user>@<site-b_mon-host-name>:/etc/ceph/site-a.conf # scp /etc/ceph/site-a.client.site-a.keyring <user>@<site-b_mon-host-name>:/etc/ceph/ # scp /etc/ceph/ceph.conf <user>@<site-b_client-host-name>:/etc/ceph/site-a.conf # scp /etc/ceph/site-a.client.site-a.keyring <user>@<site-b_client-host-name>:/etc/ceph/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記Ceph 設定ファイルを

site-bCeph Monitor ノードからsite-aの Ceph Monitor およびクライアントノードに転送するscpコマンドをし用すると、ファイルの名前がsite-a.confに変更されます。キーリングファイル名は同じままです。site-bクラスタークライアントノードのceph.confをポイントするsite-b.confという名前のシンボリックリンクを作成します。cd /etc/ceph ln -s ceph.conf site-b.conf

# cd /etc/ceph # ln -s ceph.conf site-b.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクライアントノードでrbd-mirrorデーモンを有効にして起動します。systemctl enable ceph-rbd-mirror.target systemctl enable ceph-rbd-mirror@<client-id> systemctl start ceph-rbd-mirror@<client-id>

systemctl enable ceph-rbd-mirror.target systemctl enable ceph-rbd-mirror@<client-id> systemctl start ceph-rbd-mirror@<client-id>Copy to Clipboard Copied! Toggle word wrap Toggle overflow CLIENT_IDcephxアクセスが必要です。詳細は、Red Hat Ceph Storage 管理ガイド の ユーザー管理 の章を参照してください。site-bを使用した前述の例に基づいて、以下のコマンドを実行します。systemctl enable ceph-rbd-mirror.target systemctl enable ceph-rbd-mirror@site-b systemctl start ceph-rbd-mirror@site-b

# systemctl enable ceph-rbd-mirror.target # systemctl enable ceph-rbd-mirror@site-b # systemctl start ceph-rbd-mirror@site-bCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクラスターのモニターノードで以下のコマンドを実行して、site-aクラスターにあるデータプールのプールミラーリングを有効にします。rbd mirror pool enable data pool

# rbd mirror pool enable data poolCopy to Clipboard Copied! Toggle word wrap Toggle overflow また、ミラーリングが正常に有効化されていることを確認します。

rbd mirror pool info data Mode: pool Peers: none

# rbd mirror pool info data Mode: pool Peers: noneCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-bクラスターのクライアントノードから以下のコマンドを実行して、site-aクラスターをsite-bクラスターのピアとして追加します。rbd --cluster site-b mirror pool peer add data client.site-a@site-a -n client.site-b

# rbd --cluster site-b mirror pool peer add data client.site-a@site-a -n client.site-bCopy to Clipboard Copied! Toggle word wrap Toggle overflow また、ピアが正常に追加されたことを確認します。

rbd mirror pool info data Mode: pool Peers: UUID NAME CLIENT 7e90b4ce-e36d-4f07-8cbc-42050896825d site-a client.site-a

# rbd mirror pool info data Mode: pool Peers: UUID NAME CLIENT 7e90b4ce-e36d-4f07-8cbc-42050896825d site-a client.site-aCopy to Clipboard Copied! Toggle word wrap Toggle overflow しばらく後に、

image1イメージおよび image2 イメージのステータスを確認します。それらがup+replaying状態の場合には、ミラーリングが適切に機能します。site-bクラスターの監視ノードから以下のコマンドを実行します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow

イメージのミラーリングの設定

-

データプール内のミラーリングに使用する選択したイメージの排他ロックとジャーナリングが有効になっていることを確認します。詳細は、 を参照してください。 - プールミラーリングの設定 の手順 2 - 7 に従ってください。

site-aクラスターのモニターノードから、データプールのイメージのミラーリングを有効にします。rbd mirror pool enable data image

# rbd mirror pool enable data imageCopy to Clipboard Copied! Toggle word wrap Toggle overflow また、ミラーリングが正常に有効化されていることを確認します。

rbd mirror pool info data Mode: image Peers: none

# rbd mirror pool info data Mode: image Peers: noneCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクラスターのクライアントノードから、site-bクラスターをピアとして追加します。rbd --cluster site-b mirror pool peer add data client.site-a@site-a -n client.site-b

# rbd --cluster site-b mirror pool peer add data client.site-a@site-a -n client.site-bCopy to Clipboard Copied! Toggle word wrap Toggle overflow また、ピアが正常に追加されたことを確認します。

rbd mirror pool info data Mode: image Peers: UUID NAME CLIENT 9c1da891-b9f4-4644-adee-6268fe398bf1 site-a client.site-a

# rbd mirror pool info data Mode: image Peers: UUID NAME CLIENT 9c1da891-b9f4-4644-adee-6268fe398bf1 site-a client.site-aCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクラスターのモニターノードから、image1およびimage2イメージのイメージのミラーリングを明示的に有効にします。rbd mirror image enable data/image1 Mirroring enabled rbd mirror image enable data/image2 Mirroring enabled

# rbd mirror image enable data/image1 Mirroring enabled # rbd mirror image enable data/image2 Mirroring enabledCopy to Clipboard Copied! Toggle word wrap Toggle overflow しばらく後に、

image1イメージおよび image2 イメージのステータスを確認します。それらがup+replaying状態の場合には、ミラーリングが適切に機能します。site-bクラスターの監視ノードから以下のコマンドを実行します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5. 2 つのWay Mirroring の設定

双方向のミラーリングにより、2 つのクラスター間でいずれかの方向でイメージを複製できます。いずれかのクラスターから同じイメージへの変更を書き込むことはできず、変更が伝播され、変更が反映されます。イメージがクラスターからプロモートまたは降格され、読み取り元および同期する場所が変更されます。

以下の手順では、以下を前提としています。

-

ストレージクラスターが 2 台あり、それらのクラスター間でイメージをどちらの方向にでも複製できる。以下の例では、クラスターは

site-aおよびsite-bクラスターと呼ばれます。Ceph Storage クラスターのインストールに関する情報は、『 Installation Guide for Red Hat Enterprise Linux 』または『 Installation Guide for Ubuntu 』を参照してください。 -

両方のクラスターには、

rbd-mirrorデーモンが実行されるクラスターノードが割り当てられます。site-bクラスターのデーモンはsite-aクラスターに接続してイメージをsite-bsite-aクラスターのデーモンは site-b クラスターに接続し、イメージをsite-aに同期します。Ceph クライアントのインストールに関する情報は、『 Installation Guide for Red Hat Enterprise Linux 』または「 Installation Guide for Ubuntu 」を参照してください。 -

両方のクラスターに同じ名前を持つプールが作成されます。以下の例では、プールの名前は

dataです。詳細は、『 Storage Strategies Guide 』の「 Pools 」または「Red Hat Ceph Storage 3」の章を参照してください。 -

プールにはミラーリングするイメージが含まれ、ジャーナリングを有効にしておく。以下の例では、イメージの名前は

image1およびimage2です。詳細は、「 ジャーナルの有効化 」を参照してください。

ブロックデバイスのミラーリングを設定する方法は 2 つあります。

- プール のミラーリング: プール内のすべてのイメージをミラーリングするには、以下の「プールミラー リングの設定 」に従ってください。

- イメージ のミラー リング: プール内のイメージを反映させるには、以下の「イメージのミラーリングの設定」 に従ってください。

プールミラーリングの設定

-

データプール内のすべてのイメージが排他的ロックを持ち、ジャーナリングが有効になっていることを確認します。詳細は、 を参照してください。 - 「 1-Way Mirroring の設定」の「プールミラーリングの設定」 セクションの手順 2 - 7 に従って 1 方向ミラーリングを設定します。

site-aクラスターのクライアントノードで、rbd-mirrorパッケージをインストールします。パッケージは Red Hat Ceph Storage Tools リポジトリーによって提供されます。Red Hat Enterprise Linux

yum install rbd-mirror

# yum install rbd-mirrorCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ubuntu

sudo apt-get install rbd-mirror

$ sudo apt-get install rbd-mirrorCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクラスターのクライアントノードで、CLUSTERオプションを適切なファイルに追加してクラスター名を指定します。Red Hat Enterprise Linux で、/etc/sysconfig/cephファイルを更新し、Ubuntu で、それに応じて/etc/default/cephファイルを更新します。CLUSTER=site-a

CLUSTER=site-aCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-bCeph 設定ファイルおよび RBD キーリングファイルをsite-bmonitor からsite-amonitor およびクライアントノードにコピーします。scp /etc/ceph/ceph.conf <user>@<site-a_mon-host-name>:/etc/ceph/site-b.conf scp /etc/ceph/site-b.client.site-b.keyring root@<site-a_mon-host-name>:/etc/ceph/ scp /etc/ceph/ceph.conf user@<site-a_client-host-name>:/etc/ceph/site-b.conf scp /etc/ceph/site-b.client.site-b.keyring user@<site-a_client-host-name>:/etc/ceph/

# scp /etc/ceph/ceph.conf <user>@<site-a_mon-host-name>:/etc/ceph/site-b.conf # scp /etc/ceph/site-b.client.site-b.keyring root@<site-a_mon-host-name>:/etc/ceph/ # scp /etc/ceph/ceph.conf user@<site-a_client-host-name>:/etc/ceph/site-b.conf # scp /etc/ceph/site-b.client.site-b.keyring user@<site-a_client-host-name>:/etc/ceph/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記Ceph 設定ファイルを

site-bmonitor ノードから site-a モニターノードからsite-a監視ノードに転送するscpコマンドおよびクライアントノードの名前変更をsite-b.confに変更します。キーリングファイル名は同じままです。site-aキーリングファイルをsite-aCeph Monitor ノードからsite-aクライアントノード にコピーします。scp /etc/ceph/site-a.client.site-a.keyring <user>@<site-a_client-host-name>:/etc/ceph/

# scp /etc/ceph/site-a.client.site-a.keyring <user>@<site-a_client-host-name>:/etc/ceph/Copy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクラスタークライアントノードのceph.confをポイントするsite-a.confという名前のシンボリックリンクを作成します。cd /etc/ceph ln -s ceph.conf site-a.conf

# cd /etc/ceph # ln -s ceph.conf site-a.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクライアントノードでrbd-mirrorデーモンを有効にして起動します。systemctl enable ceph-rbd-mirror.target systemctl enable ceph-rbd-mirror@<client-id> systemctl start ceph-rbd-mirror@<client-id>

systemctl enable ceph-rbd-mirror.target systemctl enable ceph-rbd-mirror@<client-id> systemctl start ceph-rbd-mirror@<client-id>Copy to Clipboard Copied! Toggle word wrap Toggle overflow $CLIENT_IDは、rbd-mirrorデーモンが使用する Ceph Storage クラスターユーザーです。ユーザーに、クラスターへの適切なcephxアクセスが必要です。詳細は、Red Hat Ceph Storage 管理ガイド の ユーザー管理 の章を参照してください。site-aを使用した前述の例に基づいて、以下のコマンドを実行します。systemctl enable ceph-rbd-mirror.target systemctl enable ceph-rbd-mirror@site-a systemctl start ceph-rbd-mirror@site-a

# systemctl enable ceph-rbd-mirror.target # systemctl enable ceph-rbd-mirror@site-a # systemctl start ceph-rbd-mirror@site-aCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-bクラスターのモニターノードで以下のコマンドを実行して、site-bクラスターにあるデータプールのプールミラーリングを有効にします。rbd mirror pool enable data pool

# rbd mirror pool enable data poolCopy to Clipboard Copied! Toggle word wrap Toggle overflow また、ミラーリングが正常に有効化されていることを確認します。

rbd mirror pool info data Mode: pool Peers: none

# rbd mirror pool info data Mode: pool Peers: noneCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクラスターのクライアントノードから以下のコマンドを実行して、site-bクラスターをsite-aクラスターのピアとして追加します。rbd --cluster site-a mirror pool peer add data client.site-b@site-b -n client.site-a

# rbd --cluster site-a mirror pool peer add data client.site-b@site-b -n client.site-aCopy to Clipboard Copied! Toggle word wrap Toggle overflow また、ピアが正常に追加されたことを確認します。

rbd mirror pool info data Mode: pool Peers: UUID NAME CLIENT dc97bd3f-869f-48a5-9f21-ff31aafba733 site-b client.site-b

# rbd mirror pool info data Mode: pool Peers: UUID NAME CLIENT dc97bd3f-869f-48a5-9f21-ff31aafba733 site-b client.site-bCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクラスターのクライアントノードからミラーリングのステータスを確認します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow イメージは

up+stopped状態である必要があります。ここでは、upはrbd-mirrorデーモンが実行中で、stoppedは、イメージが別のクラスターからのレプリケーション先ではないことを意味します。これは、イメージがこのクラスターのプライマリーであるためです。注記以前のバージョンでは、一方向ミラーリングを設定する場合は、イメージを

site-bに複製するように設定されていました。これにより、site-bクライアントノードにrbd-mirrorをインストールして、site-aからsite-bに更新を「プル」できるようになりました。この時点で、site-aクラスターはミラーリングすることができますが、イメージはこれを必要とする状態ではありません。他の方向のミラーリングは、site-aのイメージが降格され、site-bのイメージがプロモートされる場合に起動します。イメージのプロモートおよび降格方法に関する情報は、「イメージの 設定」を参照し てください。

イメージのミラーリングの設定

ミラーリングがまだ設定されていない場合に 1 方向のミラーリングを設定します。

- 1-Way Mirroring の設定 の「プールミラーリングの設定」 セクションの手順 2 -7 に従ってください。

- 「 1-Way Mirroring の設定」 セクションの手順 3 - 5 に従ってください。

- 2- Way Mirroring の設定 の「プールミラーリングの設定」 セクションの手順 3 - 7 に従います。このセクションは直前です。

site-aクラスターのクライアントノードから以下のコマンドを実行して、site-bクラスターをsite-aクラスターのピアとして追加します。rbd --cluster site-a mirror pool peer add data client.site-b@site-b -n client.site-a

# rbd --cluster site-a mirror pool peer add data client.site-b@site-b -n client.site-aCopy to Clipboard Copied! Toggle word wrap Toggle overflow また、ピアが正常に追加されたことを確認します。

rbd mirror pool info data Mode: pool Peers: UUID NAME CLIENT dc97bd3f-869f-48a5-9f21-ff31aafba733 site-b client.site-b

# rbd mirror pool info data Mode: pool Peers: UUID NAME CLIENT dc97bd3f-869f-48a5-9f21-ff31aafba733 site-b client.site-bCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクラスターのクライアントノードからミラーリングのステータスを確認します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow イメージは

up+stopped状態である必要があります。ここでは、upはrbd-mirrorデーモンが実行中で、stoppedは、イメージが別のクラスターからのレプリケーション先ではないことを意味します。これは、イメージがこのクラスターのプライマリーであるためです。注記以前のバージョンでは、一方向ミラーリングを設定する場合は、イメージを

site-bに複製するように設定されていました。これにより、site-bクライアントノードにrbd-mirrorをインストールして、site-aからsite-bに更新を「プル」できるようになりました。この時点で、site-aクラスターはミラーリングすることができますが、イメージはこれを必要とする状態ではありません。他の方向のミラーリングは、site-aのイメージが降格され、site-bのイメージがプロモートされる場合に起動します。イメージのプロモートおよび降格方法に関する情報は、「イメージの 設定」を参照し てください。

4.6. 遅延レプリケーション

一方向レプリケーションを使用する場合でも、RADOS Block Device (RBD) ミラーリングイメージ間でレプリケーションを遅延させることができます。セカンダリーイメージにレプリケーションされる前に、プライマリーイメージへの不要な変更を元に戻せるように、猶予の期間が必要な場合には、遅延レプリケーションを実装することができます。

遅延レプリケーションを実装するには、宛先ストレージクラスター内の rbd-mirror デーモンで rbd_mirroring_replay_delay = MINIMUM_DELAY_IN_SECONDS 設定オプションを指定する必要があります。この設定は、rbd-mirror デーモンが使用する ceph.conf ファイル内でグローバルに適用することも、個別のイメージベースで適用することも可能です。

特定のイメージで遅延レプリケーションを使用するには、プライマリーイメージで以下の rbd CLI コマンドを実行します。

rbd image-meta set <image-spec> conf_rbd_mirroring_replay_delay <minimum delay in seconds>

rbd image-meta set <image-spec> conf_rbd_mirroring_replay_delay <minimum delay in seconds>たとえば、プール vms のイメージ vm-1 に最小レプリケーション遅延を 10 分設定するには、以下を実行します。

rbd image-meta set vms/vm-1 conf_rbd_mirroring_replay_delay 600

rbd image-meta set vms/vm-1 conf_rbd_mirroring_replay_delay 6004.7. 一方向ミラーリングを使用した障害からの復旧

一方向のミラーリングで障害から回復するには、以下の手順を使用します。以下で、プライマリークラスターを終了してからセカンダリークラスターにフェイルオーバーする方法、およびフェイルバックする方法が紹介します。シャットダウンは、正常でもそうでなくても構いません。

以下の例では、プライマリークラスターは site-a クラスターと呼ばれ、セカンダリークラスターは site-b クラスターと呼ばれます。また、ストレージクラスターにはどちらも image1 と image2 の 2 つのイメージが含まれる data プールがあります。

一方向ミラーリングは、複数のセカンダリーサイトをサポートします。追加のセカンダリークラスターを使用している場合は、セカンダリークラスターの中から 1 つ選択してフェイルオーバーします。フェイルバック中に同じクラスターから同期します。

前提条件

- 2 つ以上の実行中のクラスター。

- 一方向ミラーリングを使用して設定されるプールのミラーリングまたはイメージミラーリング。

正常なシャットダウン後のフェイルオーバー

- プライマリーイメージを使用するクライアントをすべて停止します。この手順は、どのクライアントがイメージを使用するかにより異なります。たとえば、イメージを使用する OpenStack インスタンスからボリュームの割り当てを解除します。Red Hat OpenStack Platform ストレージガイドの ブロックストレージおよびボリューム の章を参照してください。

site-aクラスターのモニターノードで以下のコマンドを実行して、site-aクラスターにあるプライマリーイメージをデモートします。rbd mirror image demote data/image1 rbd mirror image demote data/image2

# rbd mirror image demote data/image1 # rbd mirror image demote data/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow site-bクラスターにあるプライマリー以外のイメージをプロモートするには、site-bクラスターのモニターノードで以下のコマンドを実行します。rbd mirror image promote data/image1 rbd mirror image promote data/image2

# rbd mirror image promote data/image1 # rbd mirror image promote data/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow しばらくすると、

site-bクラスターのモニターノードからイメージのステータスを確認します。up+stoppedの状態が表示されるはずです。また、説明にはprimaryが表示されるはずです。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

正常にシャットダウンされなかった場合のフェイルオーバー

- プライマリークラスターが停止していることを確認します。

- プライマリーイメージを使用するクライアントをすべて停止します。この手順は、どのクライアントがイメージを使用するかにより異なります。たとえば、イメージを使用する OpenStack インスタンスからボリュームの割り当てを解除します。Red Hat OpenStack Platform ストレージガイドの ブロックストレージおよびボリューム の章を参照してください。

site-bクラスターの監視ノードから、プライマリー以外のイメージをプロモートします。site-aストレージクラスターにデモートが伝播されないので、--force オプションを使用します。rbd mirror image promote --force data/image1 rbd mirror image promote --force data/image2

# rbd mirror image promote --force data/image1 # rbd mirror image promote --force data/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow もう一度、

site-bクラスターのモニターノードからイメージのステータスを確認します。状態として、up+stopping_replayが、説明にforce promotedと表示されるはずです。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

フェイルバックの準備

以前のプライマリークラスターが回復すると、フェイルバックを行います。

2 つのクラスターが最初に一方向ミラーリング用にのみ設定されている場合、フェイルバックを行うためにプライマリークラスターもミラーリング用に設定され、逆方向でイメージを複製する必要があります。

site-aクラスターのクライアントノードで、rbd-mirrorパッケージをインストールします。パッケージは Red Hat Ceph Storage Tools リポジトリーによって提供されます。Red Hat Enterprise Linux

yum install rbd-mirror

# yum install rbd-mirrorCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ubuntu

sudo apt-get install rbd-mirror

$ sudo apt-get install rbd-mirrorCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクラスターのクライアントノードで、CLUSTERオプションを適切なファイルに追加してクラスター名を指定します。Red Hat Enterprise Linux で、/etc/sysconfig/cephファイルを更新し、Ubuntu で、それに応じて/etc/default/cephファイルを更新します。CLUSTER=site-b

CLUSTER=site-bCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-bCeph 設定ファイルおよび RBD キーリングファイルをsite-bmonitor からsite-amonitor およびクライアントノードにコピーします。scp /etc/ceph/ceph.conf <user>@<site-a_mon-host-name>:/etc/ceph/site-b.conf scp /etc/ceph/site-b.client.site-b.keyring root@<site-a_mon-host-name>:/etc/ceph/ scp /etc/ceph/ceph.conf user@<site-a_client-host-name>:/etc/ceph/site-b.conf scp /etc/ceph/site-b.client.site-b.keyring user@<site-a_client-host-name>:/etc/ceph/

# scp /etc/ceph/ceph.conf <user>@<site-a_mon-host-name>:/etc/ceph/site-b.conf # scp /etc/ceph/site-b.client.site-b.keyring root@<site-a_mon-host-name>:/etc/ceph/ # scp /etc/ceph/ceph.conf user@<site-a_client-host-name>:/etc/ceph/site-b.conf # scp /etc/ceph/site-b.client.site-b.keyring user@<site-a_client-host-name>:/etc/ceph/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記Ceph 設定ファイルを

site-bCeph Monitor ノードからsite-aの Ceph Monitor およびクライアントノードに転送するscpコマンドをし用すると、ファイルの名前がsite-a.confに変更されます。キーリングファイル名は同じままです。site-aキーリングファイルをsite-aCeph Monitor ノードからsite-aクライアントノード にコピーします。scp /etc/ceph/site-a.client.site-a.keyring <user>@<site-a_client-host-name>:/etc/ceph/

# scp /etc/ceph/site-a.client.site-a.keyring <user>@<site-a_client-host-name>:/etc/ceph/Copy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクライアントノードでrbd-mirrorデーモンを有効にして起動します。systemctl enable ceph-rbd-mirror.target systemctl enable ceph-rbd-mirror@<client-id> systemctl start ceph-rbd-mirror@<client-id>

systemctl enable ceph-rbd-mirror.target systemctl enable ceph-rbd-mirror@<client-id> systemctl start ceph-rbd-mirror@<client-id>Copy to Clipboard Copied! Toggle word wrap Toggle overflow CLIENT_IDcephxアクセスが必要です。詳細は、Red Hat Ceph Storage 管理ガイド の ユーザー管理 の章を参照してください。site-aを使用した前述の例に基づいて、コマンドは以下のようになります。systemctl enable ceph-rbd-mirror.target systemctl enable ceph-rbd-mirror@site-a systemctl start ceph-rbd-mirror@site-a

# systemctl enable ceph-rbd-mirror.target # systemctl enable ceph-rbd-mirror@site-a # systemctl start ceph-rbd-mirror@site-aCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクラスターのクライアントノードから、site-bクラスターをピアとして追加します。rbd --cluster site-a mirror pool peer add data client.site-b@site-b -n client.site-a

# rbd --cluster site-a mirror pool peer add data client.site-b@site-b -n client.site-aCopy to Clipboard Copied! Toggle word wrap Toggle overflow 複数のセカンダリークラスターを使用している場合は、フェイルオーバー先に選択したセカンダリークラスターのみを追加し、フェイルバックから追加する必要があります。

site-aクラスターのモニターノードから、site-bクラスターが正常にピアとして追加されたことを確認します。rbd mirror pool info -p data Mode: image Peers: UUID NAME CLIENT d2ae0594-a43b-4c67-a167-a36c646e8643 site-b client.site-b

# rbd mirror pool info -p data Mode: image Peers: UUID NAME CLIENT d2ae0594-a43b-4c67-a167-a36c646e8643 site-b client.site-bCopy to Clipboard Copied! Toggle word wrap Toggle overflow

failback

以前のプライマリークラスターが回復すると、フェイルバックを行います。

site-aクラスターのモニターノードから、イメージがプライマリーかどうかを判別します。rbd info data/image1 rbd info data/image2

# rbd info data/image1 # rbd info data/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドの出力で、

mirroring primary: trueまたはmirroring primary: falseを検索し、状態を判断します。site-aクラスターのモニターノードから以下のようなコマンドを実行して、プライマリーとして一覧表示されるイメージを降格します。rbd mirror image demote data/image1

# rbd mirror image demote data/image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 正常にシャットダウンされなかった場合にのみ、イメージをもう一度同期します。

site-aストレージクラスターのモニターノードで以下のコマンドを実行し、イメージをsite-bからsite-aに再同期します。rbd mirror image resync data/image1 Flagged image for resync from primary rbd mirror image resync data/image2 Flagged image for resync from primary

# rbd mirror image resync data/image1 Flagged image for resync from primary # rbd mirror image resync data/image2 Flagged image for resync from primaryCopy to Clipboard Copied! Toggle word wrap Toggle overflow しばらくしたら、状態が

up+replayingかをチェックして、イメージの最同期が完了していることを確認します。site-a ストレージクラスターのモニターノードで以下のコマンドを実行して、イメージの状態を確認します。rbd mirror image status data/image1 rbd mirror image status data/image2

# rbd mirror image status data/image1 # rbd mirror image status data/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow

site-bクラスターのモニターノードで以下のコマンドを実行して、site-bクラスターのイメージを降格します。rbd mirror image demote data/image1 rbd mirror image demote data/image2

# rbd mirror image demote data/image1 # rbd mirror image demote data/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記複数のセカンダリークラスターがある場合、これは昇格されたセカンダリークラスターからのみ実行する必要があります。

site-aクラスターのモニターノードで以下のコマンドを実行して、site-aクラスターにあるプライマリーイメージをデモートします。rbd mirror image promote data/image1 rbd mirror image promote data/image2

# rbd mirror image promote data/image1 # rbd mirror image promote data/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクラスターの監視ノードからイメージのステータスを確認します。状態としてup+stopped、説明としてlocal image is primaryと表示されるはずです。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

双方向ミラーリングの削除

上記の Prepare for failback セクションで、双方向ミラーリングの機能は site-b クラスターから site-a クラスターへの同期を有効にするように設定されています。フェイルバックが完了すると、これらの関数を無効にすることができます。

site-aクラスターからピアとしてsite-bクラスターを削除します。rbd mirror pool peer remove data client.remote@remote --cluster local rbd --cluster site-a mirror pool peer remove data client.site-b@site-b -n client.site-a

$ rbd mirror pool peer remove data client.remote@remote --cluster local # rbd --cluster site-a mirror pool peer remove data client.site-b@site-b -n client.site-aCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクライアントでrbd-mirrorデーモンを停止して無効にします。systemctl stop ceph-rbd-mirror@<client-id> systemctl disable ceph-rbd-mirror@<client-id> systemctl disable ceph-rbd-mirror.target

systemctl stop ceph-rbd-mirror@<client-id> systemctl disable ceph-rbd-mirror@<client-id> systemctl disable ceph-rbd-mirror.targetCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

systemctl stop ceph-rbd-mirror@site-a systemctl disable ceph-rbd-mirror@site-a systemctl disable ceph-rbd-mirror.target

# systemctl stop ceph-rbd-mirror@site-a # systemctl disable ceph-rbd-mirror@site-a # systemctl disable ceph-rbd-mirror.targetCopy to Clipboard Copied! Toggle word wrap Toggle overflow

関連情報

- イメージの降格、プロモート、再同期に関する詳細は、『 ブロックデバイスガイド』 の 「イメージの設定 」を参照してください。

4.8. 双方向ミラーリングを使用した障害からの復旧

双方向ミラーリングで障害から回復するには、以下の手順を使用します。以下で、プライマリークラスターを終了してからセカンダリークラスターのミラーリングデータにフェイルオーバーする方法、およびフェイルバックする方法が紹介します。シャットダウンは、正常でもそうでなくても構いません。

以下の例では、プライマリークラスターは site-a クラスターと呼ばれ、セカンダリークラスターは site-b クラスターと呼ばれます。また、ストレージクラスターにはどちらも image1 と image2 の 2 つのイメージが含まれる data プールがあります。

前提条件

- 2 つ以上の実行中のクラスター。

- 一方向ミラーリングを使用して設定されるプールのミラーリングまたはイメージミラーリング。

正常なシャットダウン後のフェイルオーバー

- プライマリーイメージを使用するクライアントをすべて停止します。この手順は、どのクライアントがイメージを使用するかにより異なります。たとえば、イメージを使用する OpenStack インスタンスからボリュームの割り当てを解除します。Red Hat OpenStack Platform ストレージガイドの ブロックストレージおよびボリューム の章を参照してください。

site-aクラスターのモニターノードで以下のコマンドを実行して、site-aクラスターにあるプライマリーイメージをデモートします。rbd mirror image demote data/image1 rbd mirror image demote data/image2

# rbd mirror image demote data/image1 # rbd mirror image demote data/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow site-bクラスターにあるプライマリー以外のイメージをプロモートするには、site-bクラスターのモニターノードで以下のコマンドを実行します。rbd mirror image promote data/image1 rbd mirror image promote data/image2

# rbd mirror image promote data/image1 # rbd mirror image promote data/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow しばらくすると、

site-bクラスターのモニターノードからイメージのステータスを確認します。イメージのステータスは、up+stoppedの状態を表示し、プライマリーとしてリストされているはずです。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - イメージへのアクセスを再開します。この手順は、どのクライアントがイメージを使用するかにより異なります。

正常にシャットダウンされなかった場合のフェイルオーバー

- プライマリークラスターが停止していることを確認します。

- プライマリーイメージを使用するクライアントをすべて停止します。この手順は、どのクライアントがイメージを使用するかにより異なります。たとえば、イメージを使用する OpenStack インスタンスからボリュームの割り当てを解除します。Red Hat OpenStack Platform ストレージガイドの ブロックストレージおよびボリューム の章を参照してください。

site-bクラスターの監視ノードから、プライマリー以外のイメージをプロモートします。site-aストレージクラスターにデモートが伝播されないので、--force オプションを使用します。rbd mirror image promote --force data/image1 rbd mirror image promote --force data/image2

# rbd mirror image promote --force data/image1 # rbd mirror image promote --force data/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow もう一度、

site-bクラスターのモニターノードからイメージのステータスを確認します。状態として、up+stopping_replayが、説明にforce promotedと表示されるはずです。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

failback

以前のプライマリークラスターが回復すると、フェイルバックを行います。

もう一度、

site-bクラスターのモニターノードからイメージのステータスを確認します。状態としてup-stopped、説明としてlocal image is primaryと表示されるはずです。Copy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクラスターのモニターノードから、イメージがプライマリーかどうかを判別します。rbd info data/image1 rbd info data/image2

# rbd info data/image1 # rbd info data/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドの出力で、

mirroring primary: trueまたはmirroring primary: falseを検索し、状態を判断します。site-aクラスターのモニターノードから以下のようなコマンドを実行して、プライマリーとして一覧表示されるイメージを降格します。rbd mirror image demote data/image1

# rbd mirror image demote data/image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 正常にシャットダウンされなかった場合にのみ、イメージをもう一度同期します。

site-aストレージクラスターのモニターノードで以下のコマンドを実行し、イメージをsite-bからsite-aに再同期します。rbd mirror image resync data/image1 Flagged image for resync from primary rbd mirror image resync data/image2 Flagged image for resync from primary

# rbd mirror image resync data/image1 Flagged image for resync from primary # rbd mirror image resync data/image2 Flagged image for resync from primaryCopy to Clipboard Copied! Toggle word wrap Toggle overflow しばらくしたら、状態が

up+replayingかをチェックして、イメージの最同期が完了していることを確認します。site-a ストレージクラスターのモニターノードで以下のコマンドを実行して、イメージの状態を確認します。rbd mirror image status data/image1 rbd mirror image status data/image2

# rbd mirror image status data/image1 # rbd mirror image status data/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow site-bクラスターのモニターノードで以下のコマンドを実行して、site-bクラスターのイメージを降格します。rbd mirror image demote data/image1 rbd mirror image demote data/image2

# rbd mirror image demote data/image1 # rbd mirror image demote data/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記複数のセカンダリークラスターがある場合、これは昇格されたセカンダリークラスターからのみ実行する必要があります。

site-aクラスターのモニターノードで以下のコマンドを実行して、site-aクラスターにあるプライマリーイメージをデモートします。rbd mirror image promote data/image1 rbd mirror image promote data/image2

# rbd mirror image promote data/image1 # rbd mirror image promote data/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow site-aクラスターの監視ノードからイメージのステータスを確認します。状態としてup+stopped、説明としてlocal image is primaryと表示されるはずです。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

関連情報

- イメージの降格、プロモート、再同期に関する詳細は、『 ブロックデバイスガイド』 の 「イメージの設定 」を参照してください。

4.9. ミラーリングを使用したインスタンスの更新

非同期更新で Ceph Block Device ミラーリングを使用してクラスターを更新する場合は、インストールの指示に従って更新してください。次に、Ceph ブロックデバイスインスタンスを再起動します。

規定されているインスタンスの再起動の順番はありません。Red Hat では、プライマリーイメージで、プールを参照するインスタンスを再起動して、その後にミラーリングされたプールを参照するインスタンスを再起動することを推奨します。

第5章 librbd(Python)

rbd python モジュールは、RBD イメージへのファイルのようなアクセスを提供します。この組み込みツールを使用するには、rbd モジュールおよび rados モジュールをインポートする必要があります。

イメージの作成および書き込み

RADOS に接続し、IO コンテキストを開きます。

cluster = rados.Rados(conffile='my_ceph.conf') cluster.connect() ioctx = cluster.open_ioctx('mypool')cluster = rados.Rados(conffile='my_ceph.conf') cluster.connect() ioctx = cluster.open_ioctx('mypool')Copy to Clipboard Copied! Toggle word wrap Toggle overflow イメージの作成に使用する

:class:rbd.RBDオブジェクトをインスタンス化します。rbd_inst = rbd.RBD() size = 4 * 1024**3 # 4 GiB rbd_inst.create(ioctx, 'myimage', size)

rbd_inst = rbd.RBD() size = 4 * 1024**3 # 4 GiB rbd_inst.create(ioctx, 'myimage', size)Copy to Clipboard Copied! Toggle word wrap Toggle overflow イメージで I/O を実行するには、

:class:rbd.Imageオブジェクトをインスタンス化します。image = rbd.Image(ioctx, 'myimage') data = 'foo' * 200 image.write(data, 0)

image = rbd.Image(ioctx, 'myimage') data = 'foo' * 200 image.write(data, 0)Copy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、イメージの最初の 600 バイトに foo が書き込まれます。データは

:type:unicodeに指定できない点に注意してください。librbdは:c:type:charよりも幅の広い文字の処理方法を認識していません。イメージ、IO コンテキスト、および RADOS への接続を終了します。

image.close() ioctx.close() cluster.shutdown()

image.close() ioctx.close() cluster.shutdown()Copy to Clipboard Copied! Toggle word wrap Toggle overflow 念のために、これらの呼び出しごとに、個別の

:finallyブロックを割り当てる必要があります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow これは面倒な場合があるので、自動的に終了またはシャットダウンするコンテキストマネージャーとしてRados、Ioctx および Image クラスを使用できます。これらのクラスをコンテキストマネージャーとして使用すると、上記の例は以下のようになります。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第6章 カーネルモジュールの操作

カーネルモジュールの操作を使用するには、Ceph クラスターが稼働中である必要があります。

Red Hat Enterprise Linux(RHEL)以外の Linux ディストリビューション上のクライアントは許可されますが、サポートされていません。これらのクライアントを使用する際にクラスターで見つかった問題(MDS など)がある場合、Red Hat はそれらに対応しますが、原因がクライアント側にある場合は、カーネルのベンダーが問題に対処する必要があります。

6.1. イメージ一覧の取得

ブロックデバイスイメージをマウントするには、まずイメージの一覧を返します。

これを行うには、以下を実行します。

rbd list

[root@rbd-client ~]# rbd list6.2. ブロックデバイスのマッピング

rbd を使用して、イメージ名をカーネルモジュールにマッピングします。イメージ名、プール名、およびユーザー名を指定する必要があります。rbd がまだロードされていない場合は、RBD カーネルモジュールを読み込みます。

これを行うには、以下を実行します。

rbd map {image-name} --pool {pool-name} --id {user-name}

[root@rbd-client ~]# rbd map {image-name} --pool {pool-name} --id {user-name}以下に例を示します。

rbd map --pool rbd myimage --id admin

[root@rbd-client ~]# rbd map --pool rbd myimage --id admin

cephx 認証を使用する場合は、シークレットも指定する必要があります。これはキーリングまたはシークレットを含むファイルからのものである可能性があります。

これを行うには、以下を実行します。

rbd map --pool rbd myimage --id admin --keyring /path/to/keyring rbd map --pool rbd myimage --id admin --keyfile /path/to/file

[root@rbd-client ~]# rbd map --pool rbd myimage --id admin --keyring /path/to/keyring

[root@rbd-client ~]# rbd map --pool rbd myimage --id admin --keyfile /path/to/file6.3. マップブロックデバイスの表示

rbd コマンドでカーネルモジュールにマッピングされたブロックデバイスイメージを表示するには、showmapped オプションを指定します。

これを行うには、以下を実行します。

rbd showmapped

[root@rbd-client ~]# rbd showmapped6.4. ブロックデバイスのマッピング解除

rbd コマンドでブロックデバイスイメージをマッピング解除するには、unmap オプションとデバイス名を指定します(規則によりブロックデバイスのイメージ名と同じです)。

これを行うには、以下を実行します。

rbd unmap /dev/rbd/{poolname}/{imagename}

[root@rbd-client ~]# rbd unmap /dev/rbd/{poolname}/{imagename}以下に例を示します。

rbd unmap /dev/rbd/rbd/foo

[root@rbd-client ~]# rbd unmap /dev/rbd/rbd/foo第7章 Ceph ブロックデバイス設定の参照

7.1. 一般設定

- rbd_op_threads

- 詳細

- ブロックデバイス操作スレッドの数。

- 型

- 整数

- デフォルト

-

1

rbd_op_threads のデフォルト値を変更しないでください。これは、1 を超える値に設定するとデータが破損する可能性があるためです。

- rbd_op_thread_timeout

- 詳細

- ブロックデバイス操作スレッドのタイムアウト (秒単位)。

- 型

- 整数

- デフォルト

-

60

- rbd_non_blocking_aio

- 詳細

-

trueの場合、Ceph はブロックを防ぐためにワーカースレッドからブロックデバイスの非同期 I/O 操作を処理します。 - 型

- ブール値

- デフォルト

-

true

- rbd_concurrent_management_ops

- 詳細

- フライトでの同時管理操作の最大数 (イメージの削除またはサイズ変更など)。

- 型

- 整数

- デフォルト

-

10

- rbd_request_timed_out_seconds

- 詳細

- メンテナンス要求がタイムアウトするまでの秒数。

- 型

- 整数

- デフォルト

-

30

- rbd_clone_copy_on_read

- 詳細

-

trueに設定すると、コピーオン読み取りのクローン作成が有効になります。 - 型

- ブール値

- デフォルト

-

false

- rbd_enable_alloc_hint

- 詳細

-

trueの場合、割り当てヒントは有効にされ、ブロックデバイスは OSD バックエンドにヒントを発行し、予想されるサイズオブジェクトを示します。 - 型

- ブール値

- デフォルト

-

true

- rbd_skip_partial_discard

- 詳細

-

trueの場合、オブジェクト内で範囲を破棄しようとすると、ブロックデバイスは範囲のゼロを省略します。 - 型

- ブール値

- デフォルト

-

false

- rbd_tracing

- 詳細

-

Linux Trace Toolkit Next Generation User Space Tracer (LTTng-UST) トレースポイントを有効にするには、このオプションを

trueに設定します。詳細は、RBD Replay 機能を使用した RADOS Block Device (RBD) ワークロードのトレース を参照してください。 - 型

- ブール値

- デフォルト

-

false

- rbd_validate_pool

- 詳細

-

RBD の互換性について空のプールを検証するには、このオプションを

trueに設定します。 - 型

- ブール値

- デフォルト

-

true

- rbd_validate_names

- 詳細

-

イメージの仕様を検証するには、このオプションを

trueに設定します。 - 型

- ブール値

- デフォルト

-

true

7.2. デフォルトの設定

イメージを作成するデフォルト設定を上書きできます。Ceph は、2 のフォーマットでイメージを作成し、ストライピングを行わずにイメージを作成します。

- rbd_default_format

- 詳細

-

その他の形式が指定されていない場合のデフォルト形式 (

2)。フォーマット1は、librbdおよび カーネルモジュールの全バージョンと互換性がある新しいイメージの元の形式ですが、クローンなどの新しい機能をサポートしません。2形式は、librbdおよびカーネルモジュールバージョン 3.11 以降でサポートされます (ストライピングを除く)。フォーマット2により、クローン作成のサポートが追加され、今後より簡単に機能性を持たせることができます。 - 型

- 整数

- デフォルト

-

2

- rbd_default_order

- 詳細

- 他の順序が指定されていない場合のデフォルトの順番です。

- 型

- 整数

- デフォルト

-

22

- rbd_default_stripe_count

- 詳細

- 他のストライプ数が指定されていない場合、デフォルトのストライプ数。デフォルト値を変更するには、v2 機能の削除が必要です。

- 型

- 64 ビット未署名の整数

- デフォルト

-

0

- rbd_default_stripe_unit

- 詳細

-

他のストライプユニットが指定されていない場合は、デフォルトのストライプユニットです。単位を

0(オブジェクトサイズ) から変更するには、v2 ストライピング機能が必要です。 - 型

- 64 ビット未署名の整数

- デフォルト

-

0

- rbd_default_features

- 詳細

ブロックデバイスイメージの作成時にデフォルトの機能が有効になります。この設定は、2 つのイメージのみに適用されます。設定は以下のとおりです。

1: レイヤーサポート。レイヤー化により、クローンを使用できます。

2: v2 サポートのストライピング。ストライピングは、データを複数のオブジェクト全体に分散します。ストライピングは、連続の読み取り/書き込みワークロードの並行処理に役立ちます。

4: 排他的ロックのサポート。有効にすると、書き込みを行う前にクライアントがオブジェクトのロックを取得する必要があります。

8: オブジェクトマップのサポート。ブロックデバイスはシンプロビジョニングされており、実際に存在するデータのみを保存します。オブジェクトマップのサポートは、実際に存在するオブジェクト (ドライブに格納されているデータ) を追跡するのに役立ちます。オブジェクトマップを有効にすると、クローン作成用の I/O 操作が高速化され、スパースに設定されたイメージのインポートおよびエクスポートが実行されます。

16: fast-diff サポート。fast-diff サポートは、オブジェクトマップのサポートと排他的ロックのサポートに依存します。別の属性をオブジェクトマップに追加して、イメージのスナップショット間の差異の生成と、スナップショットの実際のデータ使用量がはるかに速くなります。

32: deep-flatten サポート。deep-flatten を使用すると、イメージ自体に加えて、

rbd flattenがイメージのすべてのスナップショットで機能します。これを使用しないと、イメージのスナップショットは親に依存するため、スナップショットが削除されるまで親は削除できません。deep-flatten は、スナップショットがある場合でも、クローンから親を切り離します。64: ジャーナリングサポート。ジャーナリングは、イメージの実行順にイメージへの変更をすべて記録します。これにより、リモートイメージのクラッシュ調整ミラーがローカルで使用できるようになります。

有効な機能は、数値設定の合計です。

- 型

- 整数

- デフォルト

61: レイヤー化、exclusive-lock、object-map、fast-diff、および deep-flatten が有効にされます。重要現在のデフォルト設定は RBD カーネルドライバーや古い RBD クライアントと互換性がありません。

- rbd_default_map_options

- 詳細

-

ほとんどのオプションは、主にデバッグおよびベンチマークに役立ちます。詳細は、

Map Optionsのman rbdを参照してください。 - 型

- 文字列

- デフォルト

-

""

7.3. cache_settings

Ceph ブロックデバイスのユーザー空間実装 (librbd) は Linux ページキャッシュを利用できないため、RBD キャッシュ と呼ばれる独自のインメモリーキャッシュが含まれます。RBD キャッシュは、適切に動作するハードディスクキャッシュのように動作します。OS がバリアまたはフラッシュ要求を送信すると、ダーティーデータはすべて OSD に書き込まれます。つまり、ライトバックキャッシングを使用することは、フラッシュを適切に送信する仮想マシン(つまり Linux kernel >= 2.6.32)で適切に機能する物理ハードディスクを使用するだけで安全です。キャッシュは Least Recently Used (LRU) アルゴリズムを使用し、ライトバックモードでは、スループット向上のために連続したリクエストを結合できます。

Ceph は RBD のライトバックキャッシュをサポートします。これを有効にするには、ceph.conf ファイルの [client] セクションに rbd cache = true を追加します。デフォルトでは、librbd はキャッシュを実行しません。書き込みおよび読み取りはストレージクラスターに直接移動し、データがすべてのレプリカのディスクにある場合にのみ書き込みに戻ります。キャッシュを有効にすると、rbd_cache_max_dirty の非フラッシュバイト数を超えない限り、書き込みは即座に返します。この場合、書き込みによって、十分なバイト数がフラッシュされるまでライトバックおよびブロックがトリガーされます。

Ceph は RBD のライトスルーキャッシュをサポートします。キャッシュのサイズを設定し、ターゲットと制限を設定して、ライトバックキャッシュから write-through キャッシュに切り替えることができます。write-through モードを有効にするには、rbd_cache_max_dirty を 0 に設定します。つまり、書き込みは、データがすべてのレプリカのディスクにある場合にのみ返されますが、読み取りはキャッシュから送られる可能性があります。キャッシュはクライアントのメモリーにあり、各 RBD イメージには独自のイメージがあります。キャッシュはクライアントのローカルなので、イメージにアクセスする他の条件がある場合は、一貫性がありません。RBD 上で GFS または OCFS を実行しても、キャッシュが有効になっています。

RBD の ceph.conf ファイル設定は、設定ファイルの [client] セクションで設定する必要があります。設定には以下が含まれます。

- rbd_cache

- 説明

- RADOS Block Device (RBD) のキャッシュを有効にします。

- 型

- ブール値

- 必須

- いいえ

- デフォルト

-

true

- rbd_cache_size

- 説明

- RBD キャッシュサイズ (バイト単位)。

- 型

- 64 ビット整数

- 必須

- いいえ

- デフォルト

-

32 MiB

- rbd_cache_max_dirty

- 説明

-

キャッシュがライトバックをトリガーする

ダーティー制限 (バイト単位)。0の場合、ライトスルー (ライトスルー) キャッシュを使用します。 - 型

- 64 ビット整数

- 必須

- いいえ

- 制約

-

rbd cache sizeより小さくなければなりません。 - デフォルト

-

24 MiB

- rbd_cache_target_dirty

- 説明

-

キャッシュがデータストレージにデータを書き込む前に

dirty target。キャッシュへの書き込みをブロックしません。 - 型

- 64 ビット整数

- 必須

- いいえ

- 制約

-

rbd cache max dirty未満である必要があります。 - デフォルト

-

16 MiB

- rbd_cache_max_dirty_age

- 説明

- ライトバックの開始前にダーティーデータがキャッシュ内にある秒数。

- 型

- 浮動小数点 (Float)

- 必須

- いいえ

- デフォルト

-

1.0

- rbd_cache_max_dirty_object

- 詳細

-

オブジェクトのダーティー制限:

rbd_cache_sizeからの自動計算の場合は0に設定します。 - 型

- 整数

- デフォルト

-

0

- rbd_cache_block_writes_upfront

- 詳細

-

trueの場合、aio_write呼び出しが完了するまでキャッシュへの書き込みをブロックします。falseの場合、aio_completionが呼び出される前にブロックされます。 - 型

- ブール値

- デフォルト

-

false

- rbd_cache_writethrough_until_flush

- 説明

- write-through モードで起動し、最初のフラッシュ要求が受信後に write-back に切り替えます。この有効化は Conservative ですが、rbd で実行している仮想マシンが、2.6.32 以前の Linux における virtio ドライバーと同様にフラッシュを送信することが古い場合は安全な設定です。

- 型

- ブール値

- 必須

- いいえ

- デフォルト

-

true

7.4. 親/子読み取りの設定

- rbd_balance_snap_reads

- 詳細

- Ceph は通常、プライマリー OSD からオブジェクトを読み取ります。読み取りは不変であるため、この機能を使用すると、プライマリー OSD とレプリカとの間で snap の読み取りのバランスを取ることができます。

- 型

- ブール値

- デフォルト

-

false

- rbd_localize_snap_reads

- 説明

-

rbd_balance_snap_readsはスナップショットを読み取るためにレプリカをランダム化しますが、rbd_localize_snap_readsを有効にすると、ブロックデバイスは CRUSH マップを検索し、スナップショットを読み取るために最も近い(ローカル)OSD を検索します。 - タイプ

- ブール値

- デフォルト

-

false

- rbd_balance_parent_reads

- 詳細

- Ceph は通常、プライマリー OSD からオブジェクトを読み取ります。読み取りは不変であるため、この機能を使用すると、プライマリー OSD とレプリカとの間で親読み取りのバランスを取ることができます。

- 型

- ブール値

- デフォルト

-

false

- rbd_localize_parent_reads

- 説明

-

rbd_balance_parent_readsは親を読み取るためにレプリカをランダム化しますが、rbd_localize_parent_readsを有効にすると、ブロックデバイスは CRUSH マップを検索し、親を読み取るために最も近い(ローカル)OSD を検索します。 - タイプ

- ブール値

- デフォルト

-

true

7.5. read-ahead 設定

RBD は、小規模な連続読み取りを最適化するために read-ahead/prefetching をサポートします。これは通常、仮想マシンではゲスト OS で処理する必要がありますが、ブートローダーは効率的な読み取りでは機能しない場合があります。キャッシュが無効になっている場合、先読み (read-ahead) は自動的に無効になります。

- rbd_readahead_trigger_requests

- 説明

- read-ahead をトリガーするために必要な順次読み取り要求の数。

- 型

- 整数

- 必須

- いいえ

- デフォルト

-

10

- rbd_readahead_max_bytes

- 説明

- read-ahead リクエストの最大サイズ。ゼロの場合は、read-ahead が無効になります。

- 型

- 64 ビット整数

- 必須

- いいえ

- デフォルト

-

512 KiB

- rbd_readahead_disable_after_bytes

- 説明

- この多数のバイトが RBD イメージから読み取られると、閉じられるまでそのイメージの読み取りは無効にされます。これにより、ゲスト OS が起動したら、事前に読み取れることができます。ゼロの場合は、読み取り先は有効のままになります。

- 型

- 64 ビット整数

- 必須

- いいえ

- デフォルト

-

50 MiB

7.6. ブラックリストの設定

- rbd_blacklist_on_break_lock

- 詳細

- ロックが破損しているクライアントをブラックリストに登録するかどうか。

- 型

- ブール値

- デフォルト

-

true

- rbd_blacklist_expire_seconds

- 詳細

- ブラックリストする秒数 (OSD のデフォルトの場合は 0 に設定)。

- 型

- 整数

- デフォルト

-

0

7.7. ジャーナル設定

- rbd_journal_order

- 詳細

-

ジャーナルオブジェクトの最大サイズを計算するための移動ビット数。この値は、

12から64までになります。 - 型

- 32 ビット未署名の整数

- デフォルト

-

24

- rbd_journal_splay_width

- 詳細

- アクティブなジャーナルオブジェクトの数。

- 型

- 32 ビット未署名の整数

- デフォルト

-

4

- rbd_journal_commit_age

- 詳細

- コミットの間隔 (秒単位)。

- 型

- 倍精度浮動小数点数型

- デフォルト

-

5

- rbd_journal_object_flush_interval

- 詳細

- ジャーナルオブジェクトごとの保留中のコミットの最大数。

- 型

- 整数

- デフォルト

-

0

- rbd_journal_object_flush_bytes

- 詳細

- ジャーナルオブジェクトあたりの保留中の最大バイト数。

- 型

- 整数

- デフォルト

-

0

- rbd_journal_object_flush_age

- 詳細

- 保留中のコミットの最大間隔 (秒単位)。

- 型

- 倍精度浮動小数点数型

- デフォルト

-

0

- rbd_journal_pool

- 詳細

- ジャーナルオブジェクトのプールを指定します。

- 型

- 文字列

- デフォルト

-

""

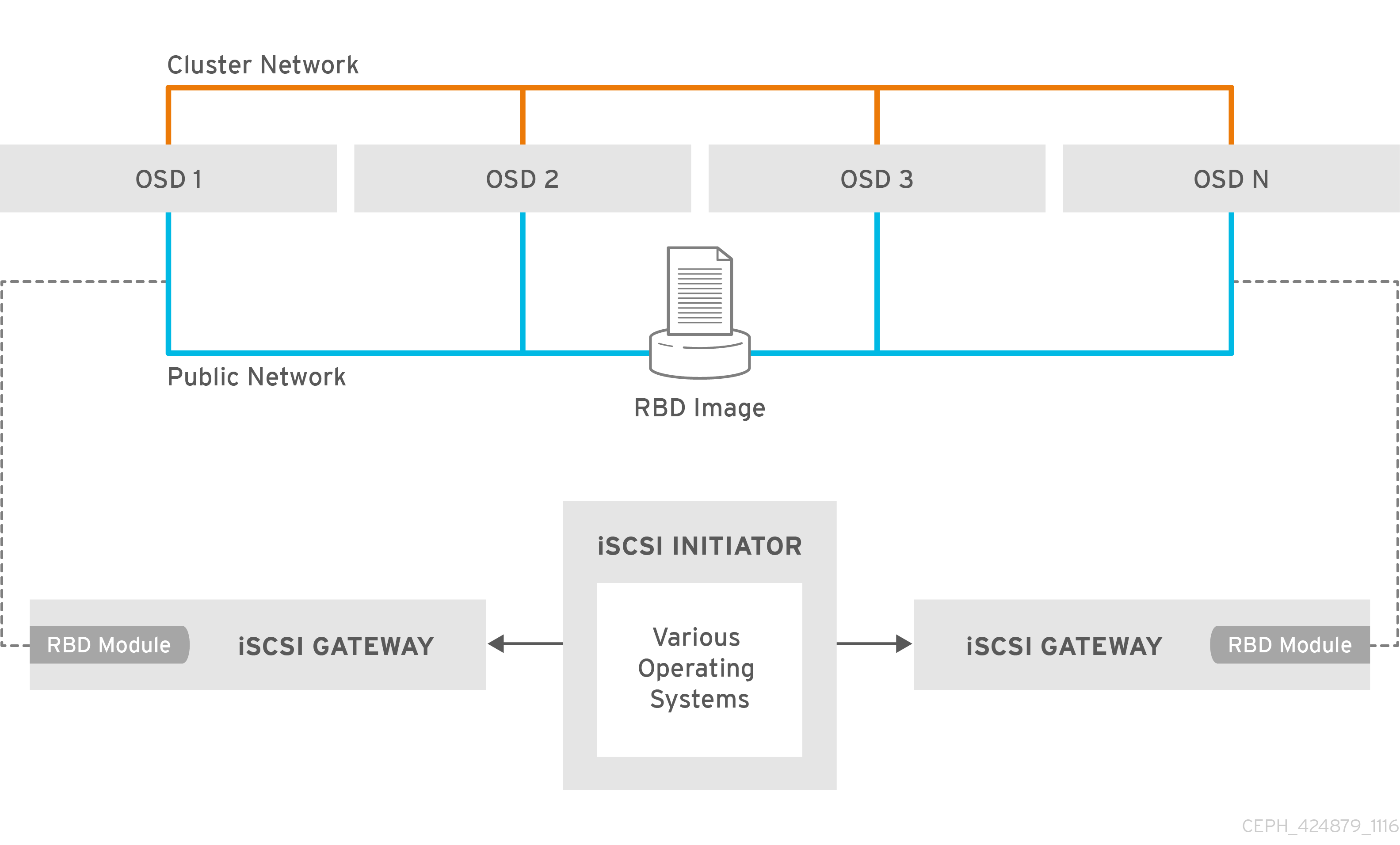

第8章 iSCSI ゲートウェイの使用

iSCSI ゲートウェイは Red Hat Ceph Storage と iSCSI 標準を統合し、RADOS Block Device (RBD) イメージを SCSI ディスクとしてエクスポートする可用性の高い (HA) iSCSI ターゲットを提供します。iSCSI プロトコルを使用すると、クライアント(initiator)は TCP/IP ネットワーク上で SCSI ストレージデバイス(ターゲット)に SCSI コマンドを送信できます。これにより、Microsoft Windows などの異種クライアントが Red Hat Ceph Storage クラスターにアクセスできるようになります。

各 iSCSI ゲートウェイは、Linux I/O ターゲットカーネルサブシステム (LIO) を実行して、iSCSI プロトコルをサポートします。LIO はユーザー空間パススルー (TCMU) を使用して Ceph librbd ライブラリーと対話し、RBD イメージを iSCSI クライアントに公開します。Ceph の iSCSI ゲートウェイの場合には、従来のストレージエリアネットワーク (SAN) のすべての機能および利点を使用して、完全に統合されたブロックストレージインフラストラクチャーを効率的に実行できます。

図8.1 Ceph iSCSI Gateway HA 設計

8.1. iSCSI ターゲットの要件

Red Hat Ceph Storage の高可用性 (HA) iSCSI ゲートウェイソリューションには、ゲートウェイノード数、メモリー容量、ダウンしている OSD を検出するタイマー設定の要件があります。

必要なノード数

最低でも 2 つの iSCSI ゲートウェイノードをインストールします。レジリエンスおよび I/O 処理を向上するには、最大 4 つの iSCSI ゲートウェイノードをインストールします。

メモリーの要件

RBD イメージのメモリーフットプリントのサイズが大きくなる可能性があります。iSCSI ゲートウェイノードにマッピングされる各 RBD イメージは、約 90 MB のメモリーを使用します。マッピングされた各 RBD イメージをサポートするのに十分なメモリーが、iSCSI ゲートウェイノードにあることを確認します。

ダウンした OSD の検出

Ceph Monitor または OSD には特定の iSCSI ゲートウェイオプションはありませんが、OSD を検出するためのデフォルトのタイマーの時間を減らし、イニシエーターがタイムアウトする可能性を少なくすることが重要です。ダウンした OSD を検出するためにタイマー設定の数値を下げる 手順に従って、イニシエーターのタイムアウトの可能性を低減します。

関連情報

- 詳細は、Red Hat Ceph Storage ハードウェアの選択ガイド を参照してください。

- 詳細は、『 ブロックデバイスガイド』 の「OSD を検出するためのタイマー設定の低い 設定」を参照してください。

8.2. ダウンしている OSD を検出するためのタイマー設定の低減

ダウンしている OSD を検出するためにタイマー設定の時間を減らす必要がある場合があります。たとえば、Red Hat Ceph Storage を iSCSI ゲートウェイとして使用する場合に、ダウンしている OSD を検出するためにタイマー設定の時間を減らすことで、イニシエーターがタイムアウトする可能性を軽減できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

手順

新しいタイマー設定を使用するように Ansible を設定します。

以下のような

group_vars/all.ymlファイルにceph_conf_overridesセクションを追加するか、既存のceph_conf_overridesセクションを編集して、osdで始まるすべての行を含めます。ceph_conf_overrides: osd: osd_client_watch_timeout: 15 osd_heartbeat_grace: 20 osd_heartbeat_interval: 5ceph_conf_overrides: osd: osd_client_watch_timeout: 15 osd_heartbeat_grace: 20 osd_heartbeat_interval: 5Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ansible Playbook の

site.ymlが OSD ノードに対して実行すると、上記の設定がceph.conf設定ファイルに追加されます。Ansible を使用して

ceph.confファイルを更新し、すべての OSD ノードで OSD デーモンを再起動します。Ansible 管理ノードで、以下のコマンドを実行します。ansible-playbook --limit osds site.yml

[user@admin ceph-ansible]$ ansible-playbook --limit osds site.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

タイマー設定が

ceph_conf_overridesで設定されている値と同じであることを確認します。1 つ以上の OSD では、

ceph daemonコマンドを使用して設定を表示します。ceph daemon osd.OSD_ID config get osd_client_watch_timeout ceph daemon osd.OSD_ID config get osd_heartbeat_grace ceph daemon osd.OSD_ID config get osd_heartbeat_interval

# ceph daemon osd.OSD_ID config get osd_client_watch_timeout # ceph daemon osd.OSD_ID config get osd_heartbeat_grace # ceph daemon osd.OSD_ID config get osd_heartbeat_intervalCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: OSD デーモンをすぐに再起動できない場合は、Ceph Monitor ノードからオンライン更新を実行します。または、すべての OSD ノードで直接更新を実行します。OSD デーモンの再起動ができたら、上記のように Ansible を使用して新しいタイマー設定を

ceph.confに追加し、設定が再起動後も維持されるようにします。Ceph Monitor ノードから OSD タイマー設定のオンライン更新を実行するには、以下を実行します。

ceph tell osd.OSD_ID injectargs '--osd_client_watch_timeout 15' ceph tell osd.OSD_ID injectargs '--osd_heartbeat_grace 20' ceph tell osd.OSD_ID injectargs '--osd_heartbeat_interval 5'

# ceph tell osd.OSD_ID injectargs '--osd_client_watch_timeout 15' # ceph tell osd.OSD_ID injectargs '--osd_heartbeat_grace 20' # ceph tell osd.OSD_ID injectargs '--osd_heartbeat_interval 5'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例:

ceph tell osd.0 injectargs '--osd_client_watch_timeout 15' ceph tell osd.0 injectargs '--osd_heartbeat_grace 20' ceph tell osd.0 injectargs '--osd_heartbeat_interval 5'