ブロックデバイスガイド

Red Hat Ceph Storage ブロックデバイスの管理、作成、設定、および使用

概要

第1章 Ceph ブロックデバイスの概要

ブロックは、シーケンスでのデータの長さ (例: 512 バイトのデータブロック) をバイト単位で設定したものです。多くのブロックを 1 つのファイルに統合すると、読み取り/書き込みが可能なストレージデバイスとして使用できます。以下のような回転メディアを使用してデータを保存する最も一般的な方法として、ブロックベースのストレージインターフェイスが挙げられます。

- ハードドライブ

- CD/DVD ディスク

- フロッピーディスク

- 従来の 9 トラックテープ

ブロックデバイスインターフェイスは偏在するので、Red Hat Ceph Storage などのマーシャルデータストレージシステムの操作には仮想ブロックデバイスが理想的です。

Ceph ブロックデバイスは、シンプロビジョニングされ、サイズ変更が可能で、Ceph Storage クラスター内の複数の Object Storage Devices (OSD) にストライプ化したストアデータです。Ceph ブロックデバイスは、Reliable Autonomic Distributed Object Store (RADOS) ブロックデバイス (RBD) としても知られています。Ceph ブロックデバイスは、以下のような RADOS 機能を利用します。

- スナップショット

- レプリケーション

- データの整合性

Ceph ブロックデバイスは、librbd ライブラリーを使用して OSD と対話します。

Ceph ブロックデバイスは、libvirt ユーティリティーおよび QEMU ユーティリティーに依存して Ceph ブロックデバイスと統合するために、Quick Emulator (QEMU) などの Kernel Virtual Machines (KVM) や OpenStack などのクラウドベースのコンピューティングシステムに、無限のスケーラビリティーと、高いパフォーマンスをもたらします。同じストレージクラスターを使用して、Ceph Object Gateway および Ceph ブロックデバイスを同時に運用できます。

Ceph ブロックデバイスを使用するには、実行中の Ceph Storage クラスターにアクセスできる必要があります。Red Hat Ceph Storage クラスターのインストールの詳細は、Red Hat Ceph Storage インストールガイド を参照してください。

第2章 Ceph ブロックデバイスコマンド

ストレージ管理者は、Ceph のブロックデバイスコマンドについて理解しておくと、Red Hat Ceph Storage クラスターを効果的に管理しやすくなります。Ceph ブロックデバイスのさまざまな機能を有効または無効にしたり、ブロックデバイスのプールとイメージを作成および管理したりできます。

2.1. 前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

2.2. コマンドのヘルプの表示

コマンドラインインターフェイスから、コマンドとサブコマンドのヘルプを表示します。

-h オプションは引き続き、使用できるすべてのコマンドのヘルプを表示します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

rbd helpコマンドを使用して、特定のrbdコマンドとそのサブコマンドのヘルプを表示します。構文

rbd help COMMAND SUBCOMMAND

rbd help COMMAND SUBCOMMANDCopy to Clipboard Copied! Toggle word wrap Toggle overflow snap listコマンドのヘルプを表示するには、次のコマンドを実行します。rbd help snap list

[root@rbd-client ~]# rbd help snap listCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. ブロックデバイスプールの作成

ブロックデバイスクライアントを使用する前に、rbd のプールが存在し、初期化されていることを確認します。

最初にプールを作成してから、これをソースとして指定する必要があります。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

rbdプールを作成するには、以下を実行します。構文

ceph osd pool create POOL_NAME PG_NUM ceph osd pool application enable POOL_NAME rbd rbd pool init -p POOL_NAME

ceph osd pool create POOL_NAME PG_NUM ceph osd pool application enable POOL_NAME rbd rbd pool init -p POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

ceph osd pool create example 128 ceph osd pool application enable example rbd rbd pool init -p example

[root@rbd-client ~]# ceph osd pool create example 128 [root@rbd-client ~]# ceph osd pool application enable example rbd [root@rbd-client ~]# rbd pool init -p exampleCopy to Clipboard Copied! Toggle word wrap Toggle overflow

関連情報

- 詳細は、Red Hat Ceph Storage ストラテジーガイドの プール の章を参照してください。

2.4. ブロックデバイスイメージの作成

ブロックデバイスをノードに追加する前に、Ceph Storage クラスターにそのイメージを作成します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

ブロックデバイスイメージを作成するには、以下のコマンドを実行します。

構文

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd create data --size 1024 --pool stack

[root@rbd-client ~]# rbd create data --size 1024 --pool stackCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例では、

stackという名前のプールに情報を格納するdataという名前のイメージが 1 GB のサイズで作成されます。注記イメージを作成する前に、プールが存在することを確認します。

関連情報

- 詳細は、Red Hat Ceph Storage ブロックデバイスガイドの ブロックデバイスプールの作成 セクションを参照してください。

2.5. ブロックデバイスイメージの一覧表示

ブロックデバイスイメージを一覧表示します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

rbdプールのブロックデバイスを一覧表示するには、以下を実行します (rbdはデフォルトのプール名です)。rbd ls

[root@rbd-client ~]# rbd lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 特定のプールのブロックデバイスを一覧表示するには、以下を実行します。ただし、

POOL_NAMEはプールの名前に置き換えます。構文

rbd ls POOL_NAME

rbd ls POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd ls swimmingpool

[root@rbd-client ~]# rbd ls swimmingpoolCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6. ブロックデバイスイメージ情報の取得

ブロックデバイスイメージに関する情報を取得します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

特定のイメージから情報を取得するには、以下を実行します。ただし、

IMAGE_NAMEはイメージの名前に置き換えます。構文

rbd --image IMAGE_NAME info

rbd --image IMAGE_NAME infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --image foo info

[root@rbd-client ~]# rbd --image foo infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow プール内のイメージから情報を取得するには、以下を実行します。ただし、

IMAGE_NAMEはイメージの名前に、POOL_NAMEはプールの名前に置き換えます。構文

rbd --image IMAGE_NAME -p POOL_NAME info

rbd --image IMAGE_NAME -p POOL_NAME infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --image bar -p swimmingpool info

[root@rbd-client ~]# rbd --image bar -p swimmingpool infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7. ブロックデバイスイメージのサイズ変更

Ceph ブロックデバイスイメージはシンプロビジョニングされています。データの保存を開始する前に、実際には物理ストレージを使用しません。ただし、--size オプションでは、設定する最大容量があります。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

Ceph ブロックデバイスイメージの最大サイズを増減するには、以下を実行します。

構文

rbd resize --image IMAGE_NAME --size SIZE

[root@rbd-client ~]# rbd resize --image IMAGE_NAME --size SIZECopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.8. ブロックデバイスイメージの削除

ブロックデバイスイメージを削除します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

ブロックデバイスを削除するには以下を実行します。ただし、

IMAGE_NAMEは削除するイメージの名前に置き換えます。構文

rbd rm IMAGE_NAME

rbd rm IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd rm foo

[root@rbd-client ~]# rbd rm fooCopy to Clipboard Copied! Toggle word wrap Toggle overflow プールからブロックデバイスを削除するには以下を実行します。ただし、

IMAGE_NAMEは、削除するイメージの名前に、POOL_NAMEはプールの名前に置き換えます。構文

rbd rm IMAGE_NAME -p POOL_NAME

rbd rm IMAGE_NAME -p POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd rm bar -p swimmingpool

[root@rbd-client ~]# rbd rm bar -p swimmingpoolCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.9. trash コマンドを使用したブロックデバイスイメージの管理

RADOS Block Device (RBD) イメージは、rbd trash コマンドを使用してゴミ箱に移動できます。

このコマンドは、以下のようなさまざまなオプションを使用できます。

- ゴミ箱からイメージを取り除く。

- ゴミ箱からイメージを一覧表示する。

- ゴミ箱からのイメージの削除を延期する。

- ゴミ箱からイメージを削除する。

- ゴミ箱からのイメージを復元する。

- ゴミ箱からイメージの復元して、名前を変更する。

- ゴミ箱から期限切れのイメージをパージする。

- ゴミ箱からパージをスケジューリングする。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

イメージをゴミ箱に移動します。

構文

rbd trash mv POOL_NAME/IMAGE_NAME

rbd trash mv POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd trash mv mypool/myimage

[root@rbd-client ~]# rbd trash mv mypool/myimageCopy to Clipboard Copied! Toggle word wrap Toggle overflow イメージがゴミ箱に入ると、一意のイメージ ID が割り当てられます。

注記ゴミ箱オプションのいずれかを使用する必要がある場合は、後でこのイメージを指定するのにこのイメージ ID が必要です。

ゴミ箱のイメージを一覧表示します。

構文

rbd trash ls POOL_NAME

rbd trash ls POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd trash ls mypool 1558a57fa43b rename_image

[root@rbd-client ~]# rbd trash ls mypool 1558a57fa43b rename_imageCopy to Clipboard Copied! Toggle word wrap Toggle overflow 一意の IMAGE_ID

1558a57fa43bは、任意のtrashオプションに使用できます。イメージをゴミ箱に移動し、ゴミ箱からイメージの削除を延期します。

構文

rbd trash mv POOL_NAME/IMAGE_NAME --expires-at "EXPIRATION_TIME"

rbd trash mv POOL_NAME/IMAGE_NAME --expires-at "EXPIRATION_TIME"Copy to Clipboard Copied! Toggle word wrap Toggle overflow EXPIRATION_TIME は、"HH:MM:SS" または "tomorrow" の秒数、時間、日付、時間です。

例

rbd trash mv mypool/myimage --expires-at "60 seconds"

[root@rbd-client ~]# rbd trash mv mypool/myimage --expires-at "60 seconds"Copy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

myimageはごみ箱に移動します。ただし、60 秒経過するまでゴミ箱から削除できません。ゴミ箱からイメージを復元します。

構文

rbd trash restore POOL_NAME/IMAGE_ID

rbd trash restore POOL_NAME/IMAGE_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd trash restore mypool/14502ff9ee4d

[root@rbd-client ~]# rbd trash restore mypool/14502ff9ee4dCopy to Clipboard Copied! Toggle word wrap Toggle overflow ゴミ箱からイメージを削除します。

構文

rbd trash rm POOL_NAME/IMAGE_ID [--force]

rbd trash rm POOL_NAME/IMAGE_ID [--force]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd trash rm mypool/14502ff9ee4d Removing image: 100% complete...done.

[root@rbd-client ~]# rbd trash rm mypool/14502ff9ee4d Removing image: 100% complete...done.Copy to Clipboard Copied! Toggle word wrap Toggle overflow イメージの削除を延期した場合は、有効期限までゴミ箱から削除できません。以下のエラーメッセージが表示されます。

例

Deferment time has not expired, please use --force if you really want to remove the image Removing image: 0% complete...failed. 2021-12-02 06:37:49.573 7fb5d237a500 -1 librbd::api::Trash: remove: error: deferment time has not expired.

Deferment time has not expired, please use --force if you really want to remove the image Removing image: 0% complete...failed. 2021-12-02 06:37:49.573 7fb5d237a500 -1 librbd::api::Trash: remove: error: deferment time has not expired.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要イメージをゴミ箱から削除したら、復元できません。

イメージの名前を変更し、ゴミ箱から元の場所に戻します。

構文

rbd trash restore POOL_NAME/IMAGE_ID --image NEW_IMAGE_NAME

rbd trash restore POOL_NAME/IMAGE_ID --image NEW_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd trash restore mypool/14502ff9ee4d --image test_image

[root@rbd-client ~]# rbd trash restore mypool/14502ff9ee4d --image test_imageCopy to Clipboard Copied! Toggle word wrap Toggle overflow ゴミ箱から期限切れのイメージを削除します。

構文

rbd trash purge POOL_NAME

rbd trash purge POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd trash purge mypool

[root@rbd-client ~]# rbd trash purge mypoolCopy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

mypoolからゴミ箱に移動したイメージをすべて削除します。

2.10. イメージ機能の有効化および無効化

既存のイメージでは、fast-diff、exclusive-lock、object-map または journaling などのイメージ機能を有効または無効にできます。

ディープフラット化 機能は、既存のイメージでのみ無効にできますが、有効化できません。ディープフラット化 を使用するには、イメージ作成時に有効化します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

機能を有効にします。

構文

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE_NAME

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow dataプールのimage1イメージでexclusive-lock機能を有効にするには、以下を実行します。例

rbd feature enable data/image1 exclusive-lock

[root@rbd-client ~]# rbd feature enable data/image1 exclusive-lockCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要fast-diffおよびobject-map機能を有効にする場合には、オブジェクトマップを再構築します。+ 構文

rbd object-map rebuild POOL_NAME/IMAGE_NAME

rbd object-map rebuild POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow

機能を無効にします。

構文

rbd feature disable POOL_NAME/IMAGE_NAME FEATURE_NAME

rbd feature disable POOL_NAME/IMAGE_NAME FEATURE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow dataプールのimage2イメージでfast-diff機能を無効にするには、以下を実行します。例

rbd feature disable data/image2 fast-diff

[root@rbd-client ~]# rbd feature disable data/image2 fast-diffCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.11. イメージメタデータの使用

Ceph は、カスタムイメージメタデータをキーと値のペアとして追加することをサポートしています。ペアには厳密な形式がありません。

また、メタデータを使用して特定のイメージの RADOS Block Device (RBD) 設定パラメーターを設定することもできます。

rbd image-meta コマンドを使用して、メタデータと連携します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

新しいメタデータのキー/値のペアを設定するには、以下を行います。

構文

rbd image-meta set POOL_NAME/IMAGE_NAME KEY VALUE

rbd image-meta set POOL_NAME/IMAGE_NAME KEY VALUECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd image-meta set data/dataset last_update 2016-06-06

[root@rbd-client ~]# rbd image-meta set data/dataset last_update 2016-06-06Copy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

last_updateキーを、dataプールのdatasetイメージの2016-06-06値に設定します。メタデータのキー/値のペアを削除するには、以下を実行します。

構文

rbd image-meta remove POOL_NAME/IMAGE_NAME KEY

rbd image-meta remove POOL_NAME/IMAGE_NAME KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd image-meta remove data/dataset last_update

[root@rbd-client ~]# rbd image-meta remove data/dataset last_updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

dataプール内のdatasetイメージからlast_updateのキーと値のペアを削除します。キーの値を表示するには、次のコマンドを実行します。

構文

rbd image-meta get POOL_NAME/IMAGE_NAME KEY

rbd image-meta get POOL_NAME/IMAGE_NAME KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd image-meta get data/dataset last_update

[root@rbd-client ~]# rbd image-meta get data/dataset last_updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

last_updateキーの値を確認します。イメージの全メタデータを表示するには、以下のコマンドを実行します。

構文

rbd image-meta list POOL_NAME/IMAGE_NAME

rbd image-meta list POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd data/dataset image-meta list

[root@rbd-client ~]# rbd data/dataset image-meta listCopy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

dataプールのdatasetイメージに設定されたメタデータを一覧表示しています。特定のイメージの Ceph 設定ファイルに設定されている RBD イメージ設定を上書きするには、以下を実行します。

構文

rbd config image set POOL_NAME/IMAGE_NAME PARAMETER VALUE

rbd config image set POOL_NAME/IMAGE_NAME PARAMETER VALUECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd config image set data/dataset rbd_cache false

[root@rbd-client ~]# rbd config image set data/dataset rbd_cache falseCopy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

dataプールのdatasetイメージの RBD キャッシュを無効にします。

関連情報

- 指定可能な設定オプションの一覧は、Red Hat Ceph Storage ブロックデバイスガイドの ブロックデバイスの一般的なオプション セクションを参照してください。

2.12. プール間のイメージの移動

同じクラスターにある異なるプール間で RADOS Block Device (RBD) イメージを移動できます。レプリケートされたプール間、イレイジャーコードのプール間、またはレプリケートされたプールとイレイジャーコードのプールの間での移行が可能です。

このプロセスで、ソースイメージはすべてのスナップショット履歴を含めて、ターゲットイメージにコピーされます。また、オプションでスパースの保持に役立つソースイメージの親へのリンクもコピーされます。ソースイメージは読み取り専用で、ターゲットイメージは書き込み可能です。移行時に、ターゲットイメージがソースイメージにリンクされます。

このプロセスは、新規ターゲットイメージの使用中に、バックグラウンドで安全に実行できます。ただし、新規ターゲットのイメージが、イメージを使用するクライアントの参照先として更新されるように、準備手順前にターゲットイメージを使用してすべてのクライアントを停止してください。

現時点では、krbd カーネルモジュールはライブ移行に対応していません。

前提条件

- ソースイメージを使用するすべてのクライアントを停止しておく。

- クライアントノードへの root レベルのアクセス。

手順

ソースおよびターゲットイメージをクロスリンクする新規ターゲットイメージを作成して、移行を準備します。

構文

rbd migration prepare SOURCE_IMAGE TARGET_IMAGE

rbd migration prepare SOURCE_IMAGE TARGET_IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下を置き換えます。

- SOURCE_IMAGE: 移動するイメージの名前に置き換えます。POOL/IMAGE_NAME 形式を使用します。

- TARGET_IMAGE: 新しいイメージの名前。POOL/IMAGE_NAME 形式を使用します。

例

rbd migration prepare data/source stack/target

[root@rbd-client ~]# rbd migration prepare data/source stack/targetCopy to Clipboard Copied! Toggle word wrap Toggle overflow 作成予定の新しいターゲットイメージの状態を確認します。構文

rbd status TARGET_IMAGE

rbd status TARGET_IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 必要に応じて、新規ターゲットイメージ名を使用してクライアントを再起動します。

ソースイメージをターゲットイメージにコピーします。

構文

rbd migration execute TARGET_IMAGE

rbd migration execute TARGET_IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd migration execute stack/target

[root@rbd-client ~]# rbd migration execute stack/targetCopy to Clipboard Copied! Toggle word wrap Toggle overflow 移行が完了したことを確認します。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ソースとターゲットイメージ間のクロスリンクを削除して移行をコミットします。これにより、ソースイメージも削除されます。

構文

rbd migration commit TARGET_IMAGE

rbd migration commit TARGET_IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd migration commit stack/target

[root@rbd-client ~]# rbd migration commit stack/targetCopy to Clipboard Copied! Toggle word wrap Toggle overflow ソースイメージが 1 つ以上のクローンの親である場合は、クローンイメージが使用されていないことを確認した後に

--forceオプションを使用します。例

rbd migration commit stack/target --force

[root@rbd-client ~]# rbd migration commit stack/target --forceCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 準備手順の後にクライアントを再起動しなかった場合は、新規ターゲットイメージ名を使用してクライアントを再起動します。

2.13. rbdmap サービス

systemd ユニットファイル、rbdmap.service は、ceph-common パッケージに含まれています。rbdmap.service ユニットは、rbdmap シェルスクリプトを実行します。

このスクリプトは、1 つ以上の RBD イメージの RADOS Block Device (RBD) のマッピングと解除を自動化しています。スクリプトはいつでも手動で実行できますが、通常のユースケースでは、システムの起動時に RBD イメージを自動的にマウントし、シャットダウン時にアンマウントします。スクリプトでは、RBD イメージをマウントする map またはマウントを解除する unmap のいずれか 1 つの引数を使用できます。。スクリプトは設定ファイルを解析します。デフォルトは /etc/ceph/rbdmap ですが、RBDMAPFILE という環境変数を使用して上書きできます。設定ファイルの各行は RBD イメージに対応します。

設定ファイルの形式は以下のようになります。

IMAGE_SPEC RBD_OPTS

ここで、IMAGE_SPEC は POOL_NAME / IMAGE_NAME、または IMAGE_NAME だけを指定します。IMAGE_NAME だけを指定する場合は、POOL_NAME は rbd に設定されます。RBD_OPTS は、基礎となる rbd map コマンドに渡すオプションの一覧です。以下のパラメーターとその値は、コンマ区切りの文字列で指定する必要があります。

OPT1=VAL1,OPT2=VAL2,…,OPT_N=VAL_N

これにより、スクリプトは以下のような rbd map コマンドを実行します。

rbd map POOLNAME/IMAGE_NAME --OPT1 VAL1 --OPT2 VAL2

コンマまたは等価記号など、オプションおよび値の場合には、これらの値が置き換えられないように、単純にアポストロフィーを使用することができます。

成功すると、rbd map の操作はイメージを /dev/rbd/rbdX デバイスにマッピングします。この時点で、udev ルールがトリガーされ、分かりやすいデバイス名のシンボリックリンク (例: /dev/rbd/POOL_NAME/IMAGE_NAME) を作成し、実際のマップされたデバイスを参照します。マウントまたはマウント解除を行うには、わかりやすいデバイス名に対応するエントリーを /etc/fstab ファイルに指定する必要があります。RBD イメージの /etc/fstab エントリーを作成する場合は、noauto または nofail マウントオプションを指定することが推奨されます。これにより、init システムが、デバイスの作成前に、先にマウントするのを防ぎます。

2.14. rbdmap サービスの設定

起動時に RADOS Block Device (RBD)、またはシャットダウン時に RADOS Block Device (RBD) を自動的にマップしてマウントするか、マップとマウントを解除します。

前提条件

- マウントを実行するノードへの Root レベルのアクセス。

-

ceph-commonパッケージのインストール。

手順

-

/etc/ceph/rbdmap設定ファイルを開いて編集します。 RBD イメージを設定ファイルに追加します。

例

foo/bar1 id=admin,keyring=/etc/ceph/ceph.client.admin.keyring foo/bar2 id=admin,keyring=/etc/ceph/ceph.client.admin.keyring,options='lock_on_read,queue_depth=1024'

foo/bar1 id=admin,keyring=/etc/ceph/ceph.client.admin.keyring foo/bar2 id=admin,keyring=/etc/ceph/ceph.client.admin.keyring,options='lock_on_read,queue_depth=1024'Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 設定ファイルに加えた変更を保存します。

RBD マッピングサービスを有効にします。

例

systemctl enable rbdmap.service

[root@client ~]# systemctl enable rbdmap.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.15. コマンドラインインターフェイスを使用した Ceph ブロックデバイスのパフォーマンスの監視

Red Hat Ceph Storage 4.1 以降、パフォーマンスメトリック収集フレームワークは、Ceph OSD および Manager コンポーネントに統合されます。このフレームワークには、他の Ceph ブロックデバイスのパフォーマンス監視ソリューションの構築時にパフォーマンスメトリックを生成して処理するための手段が含まれます。

新しい Ceph Manager モジュール rbd_support は、有効になっている場合にパフォーマンスメトリックを集約します。rbd コマンドには、iotop と iostat の新しい 2 つのアクションがあります。

これらのアクションの初回使用じには、データフィールドの設定に約 30 秒かかります。

前提条件

- Ceph Monitor ノードへのユーザーレベルのアクセス。

手順

rbd_supportCeph Manager モジュールを有効にします。例

ceph mgr module enable rbd_support

[user@mon ~]$ ceph mgr module enable rbd_supportCopy to Clipboard Copied! Toggle word wrap Toggle overflow iotop スタイルのイメージを表示するには、以下のコマンドを実行します。

例

rbd perf image iotop

[user@mon ~]$ rbd perf image iotopCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記ops、read-ops、write-bytes、read-bytes、write-latency、および read-latency の列は、右と左矢印キーを使用して動的にソートできます。

iostat スタイルのイメージを表示するには、以下を実行します。

例

rbd perf image iostat

[user@mon ~]$ rbd perf image iostatCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記このコマンドは JSON または XML 形式で出力でき、他のコマンドラインツールを使用してソートできます。

2.16. 関連情報

-

ブロックデバイスのマッピングとマッピング解除に関する詳細は、3章

rbdカーネルモジュール を参照してください。

第3章 rbd カーネルモジュール

ストレージ管理者は、rbd カーネルモジュールを使用して Ceph ブロックデバイスにアクセスできます。ブロックデバイスをマップして、マッピングを解除し、これらのマッピングを表示できます。また、rbd カーネルモジュールを使用してイメージの一覧を取得することもできます。

Red Hat Enterprise Linux (RHEL) 以外の Linux ディストリビューションのカーネルクライアントは使用できますが、サポートされていません。これらのカーネルクライアントの使用時に問題がストレージクラスターにある場合には、Red Hat は対応しますが、根本的な原因がカーネルクライアント側にある場合は、ソフトウェアベンダーが問題に対処する必要があります。

3.1. 前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

3.2. Ceph ブロックデバイスの作成および Linux カーネルモジュールクライアントからのデバイスの使用

ストレージ管理者は、Red Hat Ceph Storage ダッシュボードで Linux カーネルモジュールクライアントの Ceph ブロックデバイスを作成できます。システム管理者は、コマンドラインを使用して Linux クライアントでそのブロックデバイスをマップし、パーティション作成、フォーマットおよびマウントが可能です。その後、そのファイルの読み取りと書き込みが可能になります。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Red Hat Enterprise Linux クライアント。

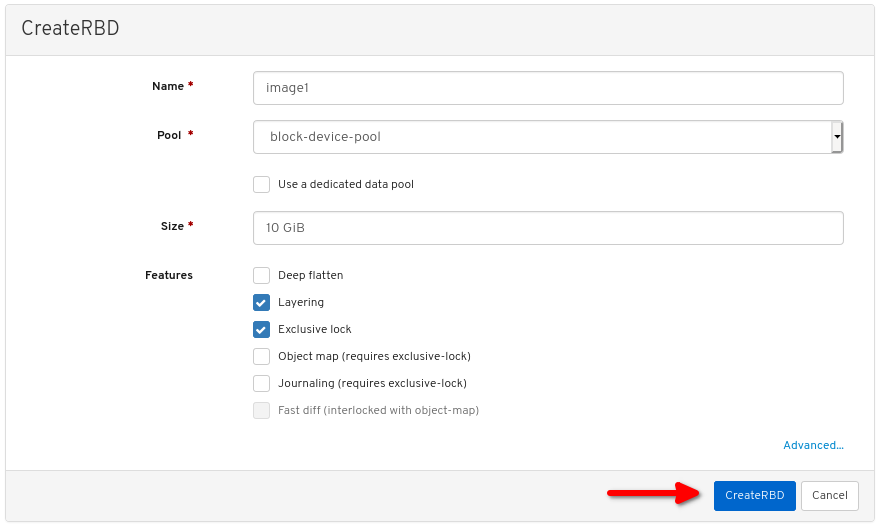

3.2.1. ダッシュボードを使用した Linux カーネルモジュールクライアントの Ceph ブロックデバイスの作成

ダッシュボードの Web インターフェイスを使用して、必要な機能だけを有効にし、Linux カーネルモジュールクライアント専用の Ceph ブロックデバイスを作成できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

手順

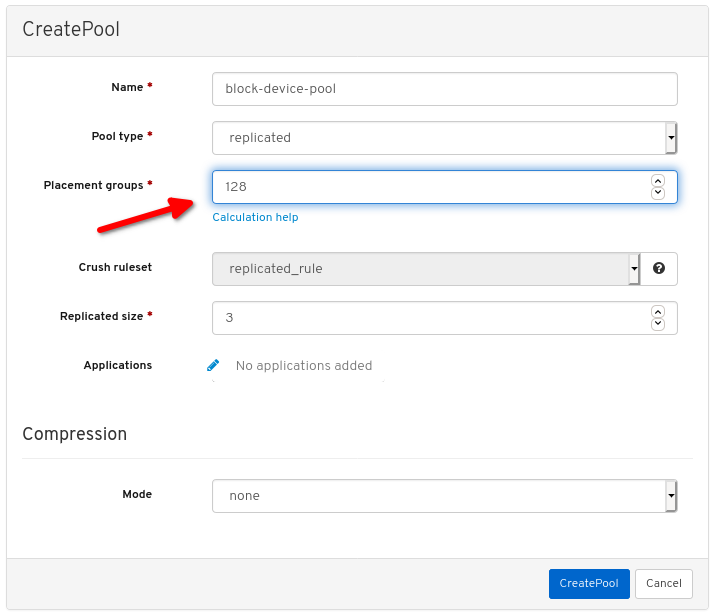

- ダッシュボードにログインします。

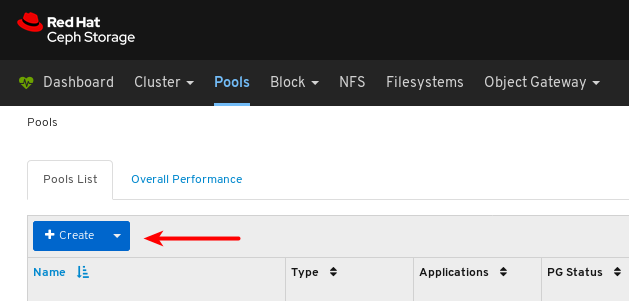

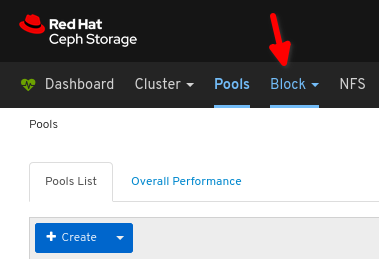

ナビゲーションバーで、Pools をクリックします。

Create ボタンをクリックします。

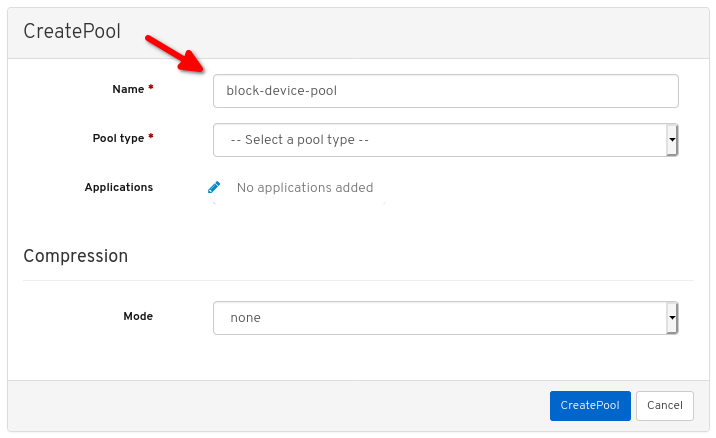

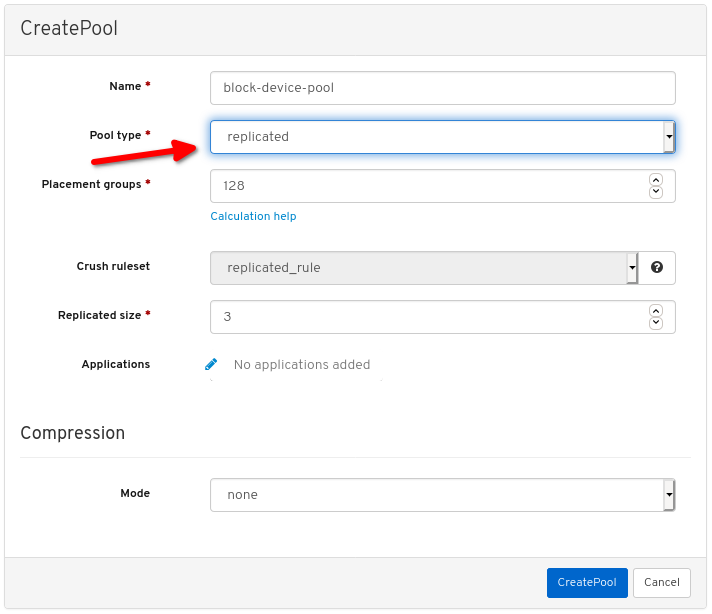

ダイアログウィンドウで、名前を設定します。

プールタイプを Replicated (レプリケート) に設定します。

配置グループ (PG) 番号を設定します。

PG 番号の選択には、PG calculator を使用します。不明な場合は、Red Hat テクニカルサポート にお問い合わせください。

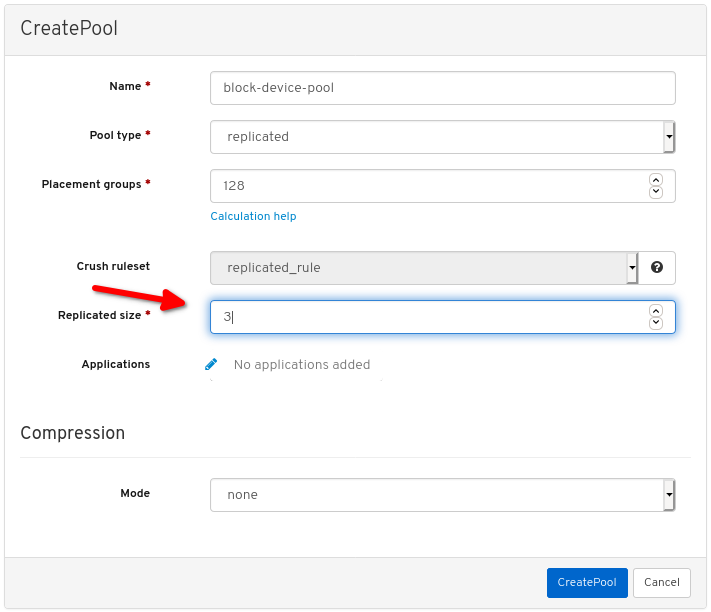

レプリケートされたサイズを設定します。

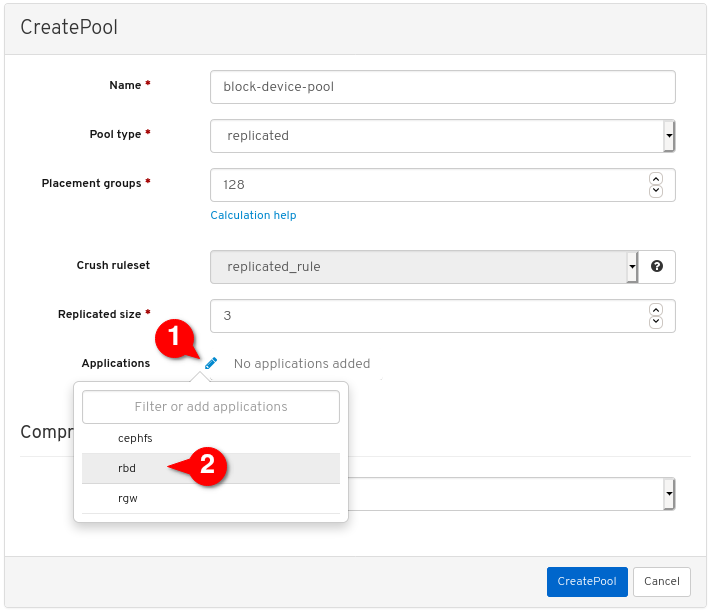

rbdアプリケーションを有効にします。

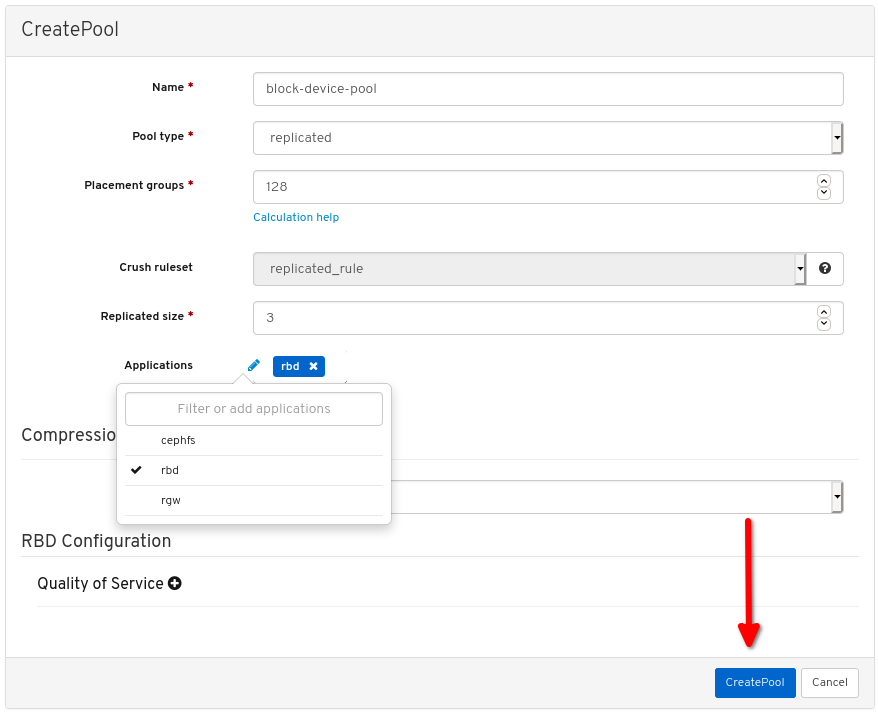

プールの作成 をクリックします。

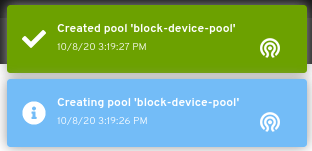

プールが正常に作成されたことを示す通知が表示されます。

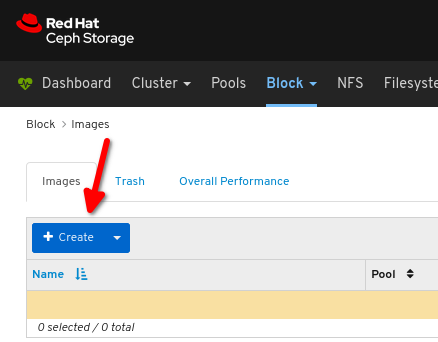

Block をクリックします。

Images をクリックします。

Create をクリックします。

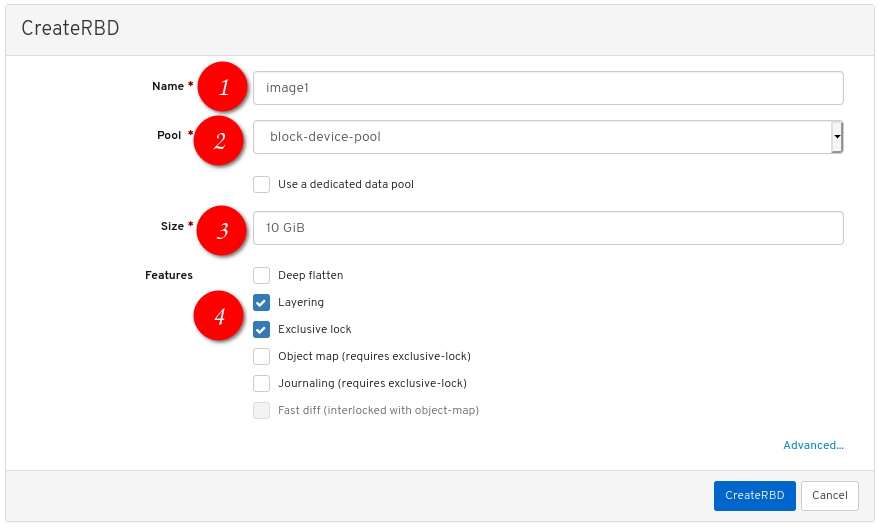

は任意のイメージ名、

は任意のイメージ名、

は先ほど作成した Pool、

は先ほど作成した Pool、

は任意サイズのイメージ、

は任意サイズのイメージ、

では Layering と Exclusive lock だけが有効な機能となるように設定します。

では Layering と Exclusive lock だけが有効な機能となるように設定します。

CreateRBD をクリックします。

イメージが正常に作成されたことを示す通知が表示されます。

関連情報

- 詳細は、コマンドラインでの Linux での Ceph ブロックデバイスのマッピングおよびマウント を参照してください。

- 詳細は、ダッシュボードガイド を参照してください。

3.2.2. コマンドラインを使用した Linux への Ceph ブロックデバイスのマッピングとマウント

Linux rbd カーネルモジュールを使用して、Red Hat Enterprise Linux クライアントから Ceph ブロックデバイスをマッピングできます。マッピング後には、パーティション、フォーマット、およびマウントができるため、ファイルに書き込みができます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Linux カーネルモジュールクライアントの Ceph ブロックデバイスが作成されている。

- Red Hat Enterprise Linux クライアント。

手順

Red Hat Enterprise Linux クライアントノードで、Red Hat Ceph Storage 4 Tools リポジトリーを有効にします。

Red Hat Enterprise Linux 7

subscription-manager repos --enable=rhel-7-server-rhceph-4-tools-rpms

[root@client1 ~]# subscription-manager repos --enable=rhel-7-server-rhceph-4-tools-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 8

subscription-manager repos --enable=rhceph-4-tools-for-rhel-8-x86_64-rpms

[root@client1 ~]# subscription-manager repos --enable=rhceph-4-tools-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow ceph-commonRPM パッケージをインストールします。Red Hat Enterprise Linux 7

yum install ceph-common

[root@client1 ~]# yum install ceph-commonCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 8

dnf install ceph-common

[root@client1 ~]# dnf install ceph-commonCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph 設定ファイルを Monitor ノードからクライアントノードにコピーします。

scp root@MONITOR_NODE:/etc/ceph/ceph.conf /etc/ceph/ceph.conf

scp root@MONITOR_NODE:/etc/ceph/ceph.conf /etc/ceph/ceph.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

scp root@cluster1-node2:/etc/ceph/ceph.conf /etc/ceph/ceph.conf root@192.168.0.32's password: ceph.conf 100% 497 724.9KB/s 00:00

[root@client1 ~]# scp root@cluster1-node2:/etc/ceph/ceph.conf /etc/ceph/ceph.conf root@192.168.0.32's password: ceph.conf 100% 497 724.9KB/s 00:00Copy to Clipboard Copied! Toggle word wrap Toggle overflow キーファイルを Monitor ノードからクライアントノードにコピーします。

scp root@MONITOR_NODE:/etc/ceph/ceph.client.admin.keyring /etc/ceph/ceph.client.admin.keyring

scp root@MONITOR_NODE:/etc/ceph/ceph.client.admin.keyring /etc/ceph/ceph.client.admin.keyringCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

scp root@cluster1-node2:/etc/ceph/ceph.client.admin.keyring /etc/ceph/ceph.client.admin.keyring root@192.168.0.32's password: ceph.client.admin.keyring 100% 151 265.0KB/s 00:00

[root@client1 ~]# scp root@cluster1-node2:/etc/ceph/ceph.client.admin.keyring /etc/ceph/ceph.client.admin.keyring root@192.168.0.32's password: ceph.client.admin.keyring 100% 151 265.0KB/s 00:00Copy to Clipboard Copied! Toggle word wrap Toggle overflow イメージをマップします。

rbd map --pool POOL_NAME IMAGE_NAME --id admin

rbd map --pool POOL_NAME IMAGE_NAME --id adminCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd map --pool block-device-pool image1 --id admin /dev/rbd0

[root@client1 ~]# rbd map --pool block-device-pool image1 --id admin /dev/rbd0 [root@client1 ~]#Copy to Clipboard Copied! Toggle word wrap Toggle overflow ブロックデバイスにパーティションテーブルを作成します。

parted /dev/MAPPED_BLOCK_DEVICE mklabel msdos

parted /dev/MAPPED_BLOCK_DEVICE mklabel msdosCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

parted /dev/rbd0 mklabel msdos Information: You may need to update /etc/fstab.

[root@client1 ~]# parted /dev/rbd0 mklabel msdos Information: You may need to update /etc/fstab.Copy to Clipboard Copied! Toggle word wrap Toggle overflow XFS ファイルシステムのパーティションを作成します。

parted /dev/MAPPED_BLOCK_DEVICE mkpart primary xfs 0% 100%

parted /dev/MAPPED_BLOCK_DEVICE mkpart primary xfs 0% 100%Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

parted /dev/rbd0 mkpart primary xfs 0% 100% Information: You may need to update /etc/fstab.

[root@client1 ~]# parted /dev/rbd0 mkpart primary xfs 0% 100% Information: You may need to update /etc/fstab.Copy to Clipboard Copied! Toggle word wrap Toggle overflow パーティションをフォーマットします。

mkfs.xfs /dev/MAPPED_BLOCK_DEVICE_WITH_PARTITION_NUMBER

mkfs.xfs /dev/MAPPED_BLOCK_DEVICE_WITH_PARTITION_NUMBERCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 新しいファイルシステムをマウントするディレクトリーを作成します。

mkdir PATH_TO_DIRECTORY

mkdir PATH_TO_DIRECTORYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

mkdir /mnt/ceph

[root@client1 ~]# mkdir /mnt/cephCopy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルシステムをマウントします。

mount /dev/MAPPED_BLOCK_DEVICE_WITH_PARTITION_NUMBER PATH_TO_DIRECTORY

mount /dev/MAPPED_BLOCK_DEVICE_WITH_PARTITION_NUMBER PATH_TO_DIRECTORYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

mount /dev/rbd0p1 /mnt/ceph/

[root@client1 ~]# mount /dev/rbd0p1 /mnt/ceph/Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルシステムがマウントされ、正しいサイズを表示していることを確認します。

df -h PATH_TO_DIRECTORY

df -h PATH_TO_DIRECTORYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

df -h /mnt/ceph/ Filesystem Size Used Avail Use% Mounted on /dev/rbd0p1 10G 105M 9.9G 2% /mnt/ceph

[root@client1 ~]# df -h /mnt/ceph/ Filesystem Size Used Avail Use% Mounted on /dev/rbd0p1 10G 105M 9.9G 2% /mnt/cephCopy to Clipboard Copied! Toggle word wrap Toggle overflow

関連情報

- 詳細は、ダッシュボードを使用した Linux カーネルモジュールクライアントの Ceph ブロックデバイスの作成 を参照してください。

- 詳細は、Red Hat Enterprise Linux 8 の ファイルシステムの管理 を参照してください。

- 詳細は、Red Hat Enterprise Linux 7 の ストレージ管理ガイド を参照してください。

3.3. イメージ一覧の取得

Ceph ブロックデバイスイメージの一覧を取得します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

ブロックデバイスイメージをマウントするには、まずイメージの一覧を返します。

rbd list

[root@rbd-client ~]# rbd listCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4. ブロックデバイスのマッピング

rbd を使用して、イメージ名をカーネルモジュールにマッピングします。イメージ名、プール名、およびユーザー名を指定する必要があります。rbd がまだロードされていない場合は、RBD カーネルモジュールを読み込みます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

イメージ名をカーネルモジュールにマッピングします。

構文

rbd device map POOL_NAME/IMAGE_NAME --id USER_NAME

rbd device map POOL_NAME/IMAGE_NAME --id USER_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd device map rbd/myimage --id admin

[root@rbd-client ~]# rbd device map rbd/myimage --id adminCopy to Clipboard Copied! Toggle word wrap Toggle overflow cephx認証を使用する場合に、キーリングか、シークレットを含むファイルでシークレットを指定します。構文

rbd device map POOL_NAME/IMAGE_NAME --id USER_NAME --keyring PATH_TO_KEYRING

[root@rbd-client ~]# rbd device map POOL_NAME/IMAGE_NAME --id USER_NAME --keyring PATH_TO_KEYRINGCopy to Clipboard Copied! Toggle word wrap Toggle overflow または

rbd device map POOL_NAME/IMAGE_NAME --id USER_NAME --keyfile PATH_TO_FILE

[root@rbd-client ~]# rbd device map POOL_NAME/IMAGE_NAME --id USER_NAME --keyfile PATH_TO_FILECopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5. マップされたブロックデバイスの表示

rbd コマンドを使用して、カーネルモジュールにマップされるブロックデバイスイメージを表示できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

マップされたブロックデバイスを表示します。

rbd device list

[root@rbd-client ~]# rbd device listCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6. ブロックデバイスのマッピング解除

unmap オプションを使用してデバイス名を指定し、rbd コマンドでブロックデバイスイメージのマッピングを解除できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

ブロックデバイスイメージのマッピングを解除します。

構文

rbd device unmap /dev/rbd/POOL_NAME/IMAGE_NAME

rbd device unmap /dev/rbd/POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd device unmap /dev/rbd/rbd/foo

[root@rbd-client ~]# rbd device unmap /dev/rbd/rbd/fooCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.7. 同じプール内の分離された名前空間内でのイメージの分離

OpenStack または OpenShift Container Storage などの上位システムなしで Ceph ブロックデバイスを直接使用する場合、特定のブロックデバイスイメージへのユーザーアクセスを制限することができませんでした。CephX 機能と組み合わせると、ユーザーを特定のプール名前空間に制限して、イメージへのアクセスを制限することができます。

新規レベルのアイデンティティーである RADOS 名前空間を使用してオブジェクトを特定し、プール内の rados クライアント間を分離できます。たとえば、クライアントは、クライアント向けの名前空間でのみ完全なパーミッションが割り当てられます。これにより、テナントごとに異なる RADOS クライアントが使用されるので、多くの異なるテナントが独自のブロックデバイスイメージにアクセスしているブロックデバイスに特に便利です。

同じプール内の分離された名前空間内でブロックデバイスイメージを分離することができます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- すべてのカーネルを 4x および librbd、全クライアントの Librados にアップグレードする。

- モニターおよびクライアントノードへの root レベルのアクセス。

手順

rbdプールを作成します。構文

ceph osd pool create POOL_NAME PG_NUM

ceph osd pool create POOL_NAME PG_NUMCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

ceph osd pool create mypool 100 pool 'mypool' created

[root@mon ~]# ceph osd pool create mypool 100 pool 'mypool' createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow rbdプールを RBD アプリケーションに関連付けます。構文

ceph osd pool application enable POOL_NAME rbd

ceph osd pool application enable POOL_NAME rbdCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

ceph osd pool application enable mypool rbd enabled application 'rbd' on pool 'mypool'

[root@mon ~]# ceph osd pool application enable mypool rbd enabled application 'rbd' on pool 'mypool'Copy to Clipboard Copied! Toggle word wrap Toggle overflow RBD アプリケーションでプールを初期化します。

構文

rbd pool init -p POOL_NAME

rbd pool init -p POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd pool init -p mypool

[root@mon ~]# rbd pool init -p mypoolCopy to Clipboard Copied! Toggle word wrap Toggle overflow 2 つの名前空間を作成します。

構文

rbd namespace create --namespace NAMESPACE

rbd namespace create --namespace NAMESPACECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ユーザー 2 つにこの名前空間へのアクセスを割り当てます。

構文

ceph auth get-or-create client.USER_NAME mon 'profile rbd' osd 'profile rbd pool=rbd namespace=NAMESPACE' -o /etc/ceph/client.USER_NAME.keyring

ceph auth get-or-create client.USER_NAME mon 'profile rbd' osd 'profile rbd pool=rbd namespace=NAMESPACE' -o /etc/ceph/client.USER_NAME.keyringCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

ceph auth get-or-create client.testuser mon 'profile rbd' osd 'profile rbd pool=rbd namespace=namespace1' -o /etc/ceph/client.testuser.keyring ceph auth get-or-create client.newuser mon 'profile rbd' osd 'profile rbd pool=rbd namespace=namespace2' -o /etc/ceph/client.newuser.keyring

[root@mon ~]# ceph auth get-or-create client.testuser mon 'profile rbd' osd 'profile rbd pool=rbd namespace=namespace1' -o /etc/ceph/client.testuser.keyring [root@mon ~]# ceph auth get-or-create client.newuser mon 'profile rbd' osd 'profile rbd pool=rbd namespace=namespace2' -o /etc/ceph/client.newuser.keyringCopy to Clipboard Copied! Toggle word wrap Toggle overflow クライアントのキーを取得します。

構文

ceph auth get client.USER_NAME

ceph auth get client.USER_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ブロックデバイスイメージを作成し、プール内の事前定義済みの名前空間を使用します。

構文

rbd create --namespace NAMESPACE IMAGE_NAME --size SIZE_IN_GB

rbd create --namespace NAMESPACE IMAGE_NAME --size SIZE_IN_GBCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd create --namespace namespace1 image01 --size 1G rbd create --namespace namespace2 image02 --size 1G

[root@mon ~]# rbd create --namespace namespace1 image01 --size 1G [root@mon ~]# rbd create --namespace namespace2 image02 --size 1GCopy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: 名前空間および関連付けられたイメージの詳細を取得します。

構文

rbd --namespace NAMESPACE ls --long

rbd --namespace NAMESPACE ls --longCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph 設定ファイルを Monitor ノードからクライアントノードにコピーします。

scp /etc/ceph/ceph.conf root@CLIENT_NODE:/etc/ceph/

scp /etc/ceph/ceph.conf root@CLIENT_NODE:/etc/ceph/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

scp /etc/ceph/ceph.conf root@host02:/etc/ceph/ root@host02's password: ceph.conf 100% 497 724.9KB/s 00:00

[root@mon ~]# scp /etc/ceph/ceph.conf root@host02:/etc/ceph/ root@host02's password: ceph.conf 100% 497 724.9KB/s 00:00Copy to Clipboard Copied! Toggle word wrap Toggle overflow 管理キーリングを Ceph Monitor ノードからクライアントノードにコピーします。

構文

scp /etc/ceph/ceph.client.admin.keyring root@CLIENT_NODE:/etc/ceph

scp /etc/ceph/ceph.client.admin.keyring root@CLIENT_NODE:/etc/cephCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

scp /etc/ceph/ceph.client.admin.keyring root@host02:/etc/ceph/ root@host02's password: ceph.client.admin.keyring 100% 151 265.0KB/s 00:00

[root@mon ~]# scp /etc/ceph/ceph.client.admin.keyring root@host02:/etc/ceph/ root@host02's password: ceph.client.admin.keyring 100% 151 265.0KB/s 00:00Copy to Clipboard Copied! Toggle word wrap Toggle overflow ユーザーのキーリングを Ceph Monitor ノードからクライアントノードにコピーします。

構文

scp /etc/ceph/ceph.client.USER_NAME.keyring root@CLIENT_NODE:/etc/ceph/

scp /etc/ceph/ceph.client.USER_NAME.keyring root@CLIENT_NODE:/etc/ceph/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

scp /etc/ceph/client.newuser.keyring root@host02:/etc/ceph/ scp /etc/ceph/client.testuser.keyring root@host02:/etc/ceph/

[root@mon ~]# scp /etc/ceph/client.newuser.keyring root@host02:/etc/ceph/ [root@mon ~]# scp /etc/ceph/client.testuser.keyring root@host02:/etc/ceph/Copy to Clipboard Copied! Toggle word wrap Toggle overflow ブロックデバイスイメージをマッピングします。

構文

rbd map --name NAMESPACE IMAGE_NAME -n client.USER_NAME --keyring /etc/ceph/client.USER_NAME.keyring

rbd map --name NAMESPACE IMAGE_NAME -n client.USER_NAME --keyring /etc/ceph/client.USER_NAME.keyringCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、同じプール内の他の名前空間のユーザーにはアクセスできません。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow デバイスを確認します。

例

rbd showmapped id pool namespace image snap device 0 rbd namespace1 image01 - /dev/rbd0 1 rbd namespace2 image02 - /dev/rbd1

[root@mon ~]# rbd showmapped id pool namespace image snap device 0 rbd namespace1 image01 - /dev/rbd0 1 rbd namespace2 image02 - /dev/rbd1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第4章 スナップショット管理

ストレージ管理者は、Ceph のスナップショット機能を十分に理解している場合には、Red Hat Ceph Storage クラスターに保存されているイメージのスナップショットの管理や、クローン作成に役立ちます。

4.1. 前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

4.2. Ceph ブロックデバイスのスナップショット

スナップショットは、特定の時点におけるイメージの状態の読み取り専用コピーです。Ceph ブロックデバイスの高度な機能の 1 つとして、イメージのスナップショットを作成して、イメージの状態の履歴を保持できることが挙げられます。Ceph は、スナップショット階層機能もサポートしており、仮想マシンイメージなどのイメージのクローンをすばやく簡単に作成できます。Ceph は、QEMU、libvirt、OpenStack、および CloudStack など、rbd コマンドと、より上層レベルのインターフェイスを使用するブロックデバイススナップショットをサポートします。

I/O の発生中にスナップショットが作成された場合、スナップショットは正確なイメージデータまたは最新のイメージデータを取得できず、マウントできる新規イメージに、スナップショットをクローンする必要がある場合があります。Red Hat は、イメージのスナップショットを作成する前に I/O を停止することを推奨します。イメージにファイルシステムが含まれる場合に、ファイルシステムはスナップショットの作成前に整合性のある状態でなければなりません。I/O を停止するには、fsfreeze コマンドを使用します。仮想マシンの場合には、qemu-guest-agent を使用してスナップショットの作成時にファイルシステムを自動的にフリーズできます。

関連情報

-

詳細は、

fsfreeze(8)の man ページを参照してください。

4.3. Ceph ユーザーおよびキーリング

cephx が有効な場合には、ユーザー名または ID とユーザーに対応するキーが含まれるキーリングへのパスを指定する必要があります。

Cephx はデフォルトで有効化されています。

以下のパラメーターのエントリーを再追加しなくてもいいように、CEPH_ARGS 環境変数を追加することもできます。

構文

rbd --id USER_ID --keyring=/path/to/secret [commands] rbd --name USERNAME --keyring=/path/to/secret [commands]

rbd --id USER_ID --keyring=/path/to/secret [commands]

rbd --name USERNAME --keyring=/path/to/secret [commands]例

rbd --id admin --keyring=/etc/ceph/ceph.keyring [commands] rbd --name client.admin --keyring=/etc/ceph/ceph.keyring [commands]

[root@rbd-client ~]# rbd --id admin --keyring=/etc/ceph/ceph.keyring [commands]

[root@rbd-client ~]# rbd --name client.admin --keyring=/etc/ceph/ceph.keyring [commands]

ユーザーとシークレットを CEPH_ARGS 環境変数に追加して、毎回入力する必要がないようにします。

4.4. ブロックデバイススナップショットの作成

Ceph ブロックデバイスのスナップショットを作成します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

snap createオプション、プール名、およびイメージ名を指定します。構文

rbd --pool POOL_NAME snap create --snap SNAP_NAME IMAGE_NAME rbd snap create POOL_NAME/IMAGE_NAME@SNAP_NAME

rbd --pool POOL_NAME snap create --snap SNAP_NAME IMAGE_NAME rbd snap create POOL_NAME/IMAGE_NAME@SNAP_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool rbd snap create --snap snapname foo rbd snap create rbd/foo@snapname

[root@rbd-client ~]# rbd --pool rbd snap create --snap snapname foo [root@rbd-client ~]# rbd snap create rbd/foo@snapnameCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5. ブロックデバイススナップショットの一覧表示

ブロックデバイスのスナップショットを一覧表示します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

プール名とイメージ名を指定します。

構文

rbd --pool POOL_NAME snap ls IMAGE_NAME rbd snap ls POOL_NAME/IMAGE_NAME

rbd --pool POOL_NAME snap ls IMAGE_NAME rbd snap ls POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool rbd snap ls foo rbd snap ls rbd/foo

[root@rbd-client ~]# rbd --pool rbd snap ls foo [root@rbd-client ~]# rbd snap ls rbd/fooCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.6. ブロックデバイススナップショットのロールバック

ブロックデバイスのスナップショットをロールバックします。

イメージをスナップショットにロールバックすると、イメージの現行バージョンがスナップショットからのデータで上書きされます。ロールバックの実行にかかる時間は、イメージのサイズとともに増加します。スナップショットにイメージを ロールバック するよりも、クローンするほうが短時間ででき、既存の状態戻す方法として推奨の方法です。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

snap rollbackオプション、プール名、イメージ名、および snap 名を指定します。構文

rbd --pool POOL_NAME snap rollback --snap SNAP_NAME IMAGE_NAME rbd snap rollback POOL_NAME/IMAGE_NAME@SNAP_NAME

rbd --pool POOL_NAME snap rollback --snap SNAP_NAME IMAGE_NAME rbd snap rollback POOL_NAME/IMAGE_NAME@SNAP_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool rbd snap rollback --snap snapname foo rbd snap rollback rbd/foo@snapname

[root@rbd-client ~]# rbd --pool rbd snap rollback --snap snapname foo [root@rbd-client ~]# rbd snap rollback rbd/foo@snapnameCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.7. ブロックデバイススナップショットの削除

Ceph ブロックデバイスのスナップショットを削除します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

snap rmオプション、プール名、イメージ名、およびスナップショット名を指定します。構文

rbd --pool POOL_NAME snap rm --snap SNAP_NAME IMAGE_NAME rbd snap rm POOL_NAME-/IMAGE_NAME@SNAP_NAME

rbd --pool POOL_NAME snap rm --snap SNAP_NAME IMAGE_NAME rbd snap rm POOL_NAME-/IMAGE_NAME@SNAP_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool rbd snap rm --snap snapname foo rbd snap rm rbd/foo@snapname

[root@rbd-client ~]# rbd --pool rbd snap rm --snap snapname foo [root@rbd-client ~]# rbd snap rm rbd/foo@snapnameCopy to Clipboard Copied! Toggle word wrap Toggle overflow

イメージにクローンがある場合には、クローン作成されたイメージは、親イメージのスナップショットへの参照を保持します。親イメージのスナップショットを削除するには、最初に子イメージをフラット化する必要があります。

Ceph OSD デーモンはデータを非同期的に削除するため、スナップショットを削除してもディスク領域がすぐに解放されません。

関連情報

- 詳細は、Red Hat Ceph Storage ブロックデバイスガイドの クローンしたイメージ を参照してください。

4.8. ブロックデバイススナップショットのパージ

ブロックデバイススナップショットをパージします。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

snap purgeオプションとイメージ名を指定します。構文

rbd --pool POOL_NAME snap purge IMAGE_NAME rbd snap purge POOL_NAME/IMAGE_NAME

rbd --pool POOL_NAME snap purge IMAGE_NAME rbd snap purge POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool rbd snap purge foo rbd snap purge rbd/foo

[root@rbd-client ~]# rbd --pool rbd snap purge foo [root@rbd-client ~]# rbd snap purge rbd/fooCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.9. ブロックデバイススナップショットの名前変更

ブロックデバイスのスナップショットの名前を変更します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

スナップショットの名前を変更するには、以下のコマンドを実行します。

構文

rbd snap rename POOL_NAME/IMAGE_NAME@ORIGINAL_SNAPSHOT_NAME POOL_NAME/IMAGE_NAME@NEW_SNAPSHOT_NAME

rbd snap rename POOL_NAME/IMAGE_NAME@ORIGINAL_SNAPSHOT_NAME POOL_NAME/IMAGE_NAME@NEW_SNAPSHOT_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd snap rename data/dataset@snap1 data/dataset@snap2

[root@rbd-client ~]# rbd snap rename data/dataset@snap1 data/dataset@snap2Copy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、

dataプールにあるデータセットイメージのsnap1スナップショットの名前がsnap2に変更されます。-

rbd help snap renameコマンドを実行して、スナップショットの名前変更に関する追加情報を表示します。

4.10. Ceph ブロックデバイスの階層化

Ceph は、ブロックデバイススナップショットの多数のコピーオンライト (COW) またはコピーオンリード (COR) のクローンを作成する機能をサポートしています。スナップショットの階層化により、Ceph ブロックデバイスクライアントはイメージを非常に迅速に作成できます。たとえば、Linux 仮想マシンで書き込んだブロックデバイスイメージを作成できます。次に、イメージのスナップショットを作成して、スナップショットを保護し、必要な数のクローンを作成します。スナップショットは読み取り専用であるため、スナップショットのクローンを作成するとセマンティクスが簡素化され、クローンの作成時間を短縮できます。

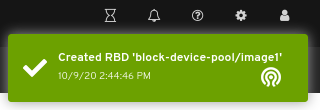

親 および 子 という用語は、Ceph ブロックデバイスのスナップショット (親)、およびスナップショットからクローン作成された対応のイメージ (子) を意味します。以下のコマンドラインを使用する場合に、これらの用語が重要です。

クローン作成された各イメージ (子) は、親イメージへの参照を保存し、クローン作成されたイメージで親スナップショットを開き、読み取ることができるようになります。この参照は、クローンが フラット化 (スナップショットからの情報が完全にクローンにコピー) されると、削除されます。

スナップショットのクローン作成は、他の Ceph ブロックデバイスイメージのように動作します。クローン作成されたイメージを読み取り、書き込み、クローンし、サイズを変更できます。クローン作成されたイメージには、特別な制限はありません。ただし、スナップショットのクローンはスナップショットを参照するので、クローンを作成する前にスナップショットを保護する 必要があります。

スナップショットのクローンは、コピーオンライト (COW) またはコピーオンリード (COR) のいずれかです。クローンではコピーオンライト (COW) は常に有効で、コピーオンリード (COR) は明示的に有効化する必要があります。コピーオンライト (COW) は、クローン内の未割り当てのオブジェクトへの書き込み時に、親からクローンにデータをコピーします。コピーオンリード (COR) は、クローン内の未割り当てのオブジェクトから読み取る時に、親からクローンにデータをコピーします。クローンからデータの読み取りは、オブジェクトがクローンに存在しない場合、親からのデータのみを読み取ります。RADOS ブロックデバイスは、サイズの大きいイメージを複数のオブジェクトに分割します。デフォルトは 4 MB に設定され、すべてのコピーオンライト (COW) およびすべてのコピーオンリード (COR) 操作が完全なオブジェクトで行われます。つまり、クローンに 1 バイトが書き込まれると、4 MB オブジェクトが親から読み取られ、まだ以前の COW/COR 操作から宛先オブジェクトがクローンに存在しない場合には、クローンに書き込まれます。

コピーオンリード (COR) が有効になっているかどうか。クローンから下層にあるオブジェクトを読み取ることができない場合には、親に再ルーティングされます。実質的に親の数に制限が特にないため、クローンのクローンを作成できます。これは、オブジェクトが見つかるまで、またはベースの親イメージに到達するまで、この再ルーティングが続行されます。コピーオンリード (COR) が有効になっている場合には、クローンから直接読み取ることができない場合には、親からすべてのオブジェクトを読み取り、そのデータをクローンに書き込むことで、今後、親から読み取る必要なく、同じエクステントの読み取りがクローン自体で行われるようにします。

これは基本的に、オンデマンドのオブジェクトごとのフラット化操作です。これは、クローンが親から離れた高遅延接続の場所 (別の地理的場所の別のプールにある親など) にある場合に特に便利です。コピーオンリード (COR) では、読み取りのならし遅延が短縮されます。最初の数回読み取りは、親から追加のデータが読み取られるため、レイテンシーが高くなっています。たとえば、クローンから 1 バイトを読み取る場合に、4 MB を親から読み取り、クローンに書き込みする必要がありますが、それ以降はクローン自体からすべての読み取りが行われます。

スナップショットからコピーオンリード (COR) のクローンを作成するには、ceph.conf ファイルの [global] セクションまたは [client] セクションに rbd_clone_copy_on_read = true を追加してこの機能を明示的に有効にする必要があります。

関連情報

-

フラット化の詳細は、Red Hat Ceph Storage ブロックデバイスガイドの クローン作成されたイメージのフラット化 セクションを参照してください。

4.11. ブロックデバイススナップショットの保護

親スナップショットのクローン作成は、親スナップショットにアクセスします。ユーザーが親のスナップショットを誤って削除した場合に、クローンはすべて破損します。データの損失を防ぐために、デフォルトで、スナップショットをクローンする前に保護する必要があります。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

以下のコマンドで

POOL_NAME、IMAGE_NAME、およびSNAP_SHOT_NAMEを指定します。構文

rbd --pool POOL_NAME snap protect --image IMAGE_NAME --snap SNAPSHOT_NAME rbd snap protect POOL_NAME/IMAGE_NAME@SNAPSHOT_NAME

rbd --pool POOL_NAME snap protect --image IMAGE_NAME --snap SNAPSHOT_NAME rbd snap protect POOL_NAME/IMAGE_NAME@SNAPSHOT_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool rbd snap protect --image my-image --snap my-snapshot rbd snap protect rbd/my-image@my-snapshot

[root@rbd-client ~]# rbd --pool rbd snap protect --image my-image --snap my-snapshot [root@rbd-client ~]# rbd snap protect rbd/my-image@my-snapshotCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記保護されたスナップショットは削除できません。

4.12. ブロックデバイススナップショットのクローン作成

ブロックデバイスのスナップショットのクローンを作成して、同じプール内または別のプール内に、スナップショットの子イメージ (読み取りまたは書き込みイメージ) を作成します。ユースケースの例として、読み取り専用のイメージおよびスナップショットをプールでテンプレートとして維持し、別のプールで書き込み可能なクローンとして維持します。

デフォルトでは、クローンを作成する前に、スナップショットを保護する必要があります。クローンの作成前にスナップショットを保護しなくてもいいようにするには、ceph osd set-require-min-compat-client mimic を設定します。これは mimic よりも高い値に設定できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

スナップショットのクローンを作成するには、親プール、スナップショット、子プール、およびイメージ名を指定する必要があります。

構文

rbd --pool POOL_NAME --image PARENT_IMAGE --snap SNAP_NAME --dest-pool POOL_NAME --dest CHILD_IMAGE_NAME rbd clone POOL_NAME/PARENT_IMAGE@SNAP_NAME POOL_NAME/CHILD_IMAGE_NAME

rbd --pool POOL_NAME --image PARENT_IMAGE --snap SNAP_NAME --dest-pool POOL_NAME --dest CHILD_IMAGE_NAME rbd clone POOL_NAME/PARENT_IMAGE@SNAP_NAME POOL_NAME/CHILD_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool rbd --image my-image --snap my-snapshot --dest-pool rbd --dest new-image rbd clone rbd/my-image@my-snapshot rbd/new-image

[root@rbd-client ~]# rbd --pool rbd --image my-image --snap my-snapshot --dest-pool rbd --dest new-image [root@rbd-client ~]# rbd clone rbd/my-image@my-snapshot rbd/new-imageCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.13. ブロックデバイススナップショットの保護解除

スナップショットを削除する前に、そのスナップショットを保護解除する必要があります。さらに、クローンからの参照があるスナップショットは、削除できません。スナップショットを削除する前に、スナップショットの各クローンをフラット化する必要があります。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

以下のコマンドを実行します。

構文

rbd --pool POOL_NAME snap unprotect --image IMAGE_NAME --snap SNAPSHOT_NAME rbd snap unprotect POOL_NAME/IMAGE_NAME@SNAPSHOT_NAME

rbd --pool POOL_NAME snap unprotect --image IMAGE_NAME --snap SNAPSHOT_NAME rbd snap unprotect POOL_NAME/IMAGE_NAME@SNAPSHOT_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool rbd snap unprotect --image my-image --snap my-snapshot rbd snap unprotect rbd/my-image@my-snapshot

[root@rbd-client ~]# rbd --pool rbd snap unprotect --image my-image --snap my-snapshot [root@rbd-client ~]# rbd snap unprotect rbd/my-image@my-snapshotCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.14. スナップショットの子の一覧表示

スナップショットの子を一覧表示します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

スナップショットの子を一覧表示するには、以下のコマンドを実行します。

構文

rbd --pool POOL_NAME children --image IMAGE_NAME --snap SNAP_NAME rbd children POOL_NAME/IMAGE_NAME@SNAPSHOT_NAME

rbd --pool POOL_NAME children --image IMAGE_NAME --snap SNAP_NAME rbd children POOL_NAME/IMAGE_NAME@SNAPSHOT_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool rbd children --image my-image --snap my-snapshot rbd children rbd/my-image@my-snapshot

rbd --pool rbd children --image my-image --snap my-snapshot rbd children rbd/my-image@my-snapshotCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.15. クローンしたイメージのフラット化

クローン作成されたイメージは、親スナップショットへの参照を保持します。親スナップショットへの参照を子クローンから削除すると、実質的に、その情報をスナップショットからクローンにコピーしてイメージをフラット化できます。クローンのフラット化にかかる時間は、スナップショットのサイズとともに増加します。フラット化イメージにはスナップショットからのすべての情報が含まれるため、フラット化されるイメージは階層化されたクローンよりも多くのストレージ領域を使用します。

イメージで ディープフラット 機能が有効になっている場合には、イメージのクローンは、デフォルトで親から分離されます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

子イメージに関連付けられた親イメージのスナップショットを削除するには、最初に子イメージをフラット化する必要があります。

構文

rbd --pool POOL_NAME flatten --image IMAGE_NAME rbd flatten POOL_NAME/IMAGE_NAME

rbd --pool POOL_NAME flatten --image IMAGE_NAME rbd flatten POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool rbd flatten --image my-image rbd flatten rbd/my-image

[root@rbd-client ~]# rbd --pool rbd flatten --image my-image [root@rbd-client ~]# rbd flatten rbd/my-imageCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第5章 Ceph ブロックデバイスのミラーリング

ストレージ管理者は、Red Hat Ceph Storage クラスター間でデータイメージをミラーリングして、冗長性向けに別の階層を Ceph ブロックデバイスに追加できます。Ceph ブロックデバイスのミラーリングについて理解して使用すると、サイト障害など、データ損失から守ることができます。Ceph ブロックデバイスのミラーリングには、一方向ミラーリングまたは双方向ミラーリングの 2 つの設定があり、プールと個別のイメージにミラーリングを設定できます。

5.1. 前提条件

- 少なくとも、正常に実行されている Red Hat Ceph Storage クラスター 2 台。

- 2 つのストレージクラスター間のネットワーク接続。

- 各 Red Hat Ceph Storage クラスターの Ceph クライアントノードへのアクセス。

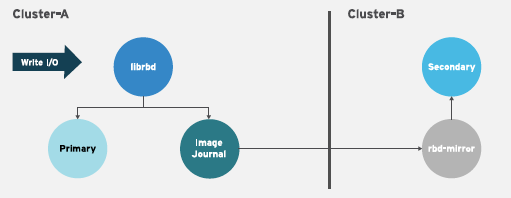

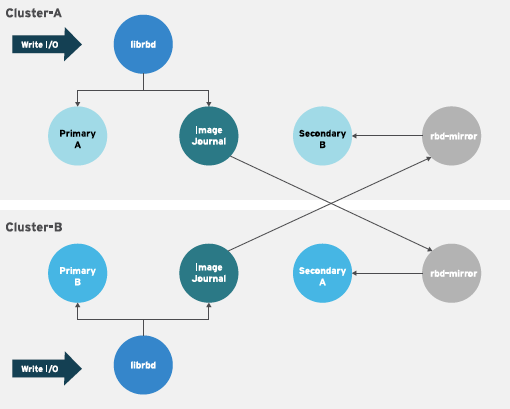

5.2. Ceph ブロックデバイスのミラーリング

RADOS Block Device (RBD) ミラーリングとは、2 つ以上の Ceph Storage クラスター間で Ceph ブロックデバイスイメージを非同期にレプリケーションするプロセスのことです。異なる地理的な場所にある Ceph Storage クラスターを配置することで、RBD ミラーリングはサイトの障害からの復旧に役立ちます。ジャーナルベースの Ceph ブロックデバイスのミラーリングにより、読み取りと書き込み、ブロックデバイスのサイズ調整、スナップショット、クローンおよびフラット化など、イメージに対する全変更を含む、ある時点の一貫したレプリカが作成されるようにします。

RBD ミラーリングは排他的ロックとジャーナリング機能を使用して、イメージに対するすべての変更を順番に記録します。これにより、イメージのクラッシュ整合性のあるミラーが利用できるようになりました。

ブロックデバイスイメージをミラーリングするプライマリーおよびセカンダリープールに対応する CRUSH 階層には、容量とパフォーマンスの特性が同じである必要があり、また、追加のレイテンシーなしにミラーリングを行うために十分な帯域幅が必要になります。たとえば、プライマリーストレージクラスター内のイメージへの平均書き込みスループットが X MB/s である場合に、ネットワークはセカンダリーサイトへのネットワーク接続で N * X スループットと、N イメージをミラーリングする安全係数 Y% に対応している必要があります。

rbd-mirror デーモンは、リモートプライマリーイメージから変更を取得し、プライマリーイメージ以外のローカルイメージにそれらの変更を書き込むことで、別の Ceph Storage クラスターにイメージを同期します。rbd-mirror デーモンは、Ceph Storage クラスター 1 台では一方向ミラーリング、Ceph Storage クラスター 2 台ではミラーリング関係に参加する双方向ミラーリングを実行します。

一方向または双方向レプリケーションのどちらかを使用して RBD ミラーリングを機能させる場合に、いくつかの前提条件があります。

- 同じ名前のプールが両方のストレージクラスターに存在する。

- プールには、ジャーナルが有効化された、ミラーリングするイメージが含まれている。

一方向または双方向レプリケーションでは、rbd-mirror の各インスタンスは他の Ceph Storage クラスターを同時に接続できる必要があります。また、ミラーリングを処理するために、ネットワークには 2 つのデータセンターサイトの間で十分な帯域幅が必要です。

一方向レプリケーション

一方向ミラーリングは、ストレージクラスター内のプライマリーイメージまたはプールのイメージがセカンダリーのストレージクラスターにレプリケートされることを意味します。一方向ミラーリングは、複数のセカンダリーストレージクラスターへのレプリケーションにも対応します。

セカンダリーストレージクラスターでは、イメージはプライマリー以外のレプリケーションであるため、Ceph クライアントはイメージに書き込むことができません。データがプライマリーストレージクラスターからセカンダリーストレージクラスターにミラーリングされると、rbd-mirror はセカンダリーストレージクラスター上でのみを実行します。

一方向のミラーリングを機能させるには、いくつかの前提条件があります。

- 2 つの Ceph Storage クラスターがあり、プライマリーストレージクラスターからセカンダリーストレージクラスターにイメージをレプリケートする必要がある。

-

セカンダリーストレージクラスターには、

rbd-mirrorデーモンを実行する Ceph クライアントノードがアタッチされている。rbd-mirrorデーモンは、プライマリーストレージクラスターに接続して、イメージをセカンダリーストレージクラスターに同期します。

双方向レプリケーション

双方向レプリケーションは、プライマリークラスターに rbd-mirror デーモンを追加して、そのクラスターでイメージをデモートし、セカンダリークラスターでプロモートできるようにします。その後、セカンダリークラスターのイメージに対して変更が行われ、セカンダリーからプライマリーに逆方向にレプリケートされます。どちらかのクラスターでのイメージのプロモートとデモートを可能にするには、両方のクラスターで rbd-mirror が実行されている必要があります。現在、双方向レプリケーションは 2 つのサイトの間でのみサポートされています。

双方向のミラーリングを機能させるには、いくつかの前提条件があります。

- ストレージクラスターが 2 台あり、それらのクラスター間でイメージをどちらの方向にでも複製できる。

-

両方のストレージクラスターには、

rbd-mirrorデーモンを実行するクライアントノードが割り当てられている。セカンダリーストレージクラスターで実行されるrbd-mirrorデーモンは、プライマリーストレージクラスターに接続してイメージをセカンダリーに同期し、プライマリーストレージクラスターで実行されているrbd-mirrorデーモンは、セカンダリーストレージクラスターに接続し、イメージをプライマリーに同期します。

Red Hat Ceph Storage 4 では、1 つのクラスターで複数のアクティブな rbd-mirror デーモンを実行するがサポートされます。

ミラーリングモード

ミラーリングは、ストレージクラスターのミラーリングを使用して、プールごとに設定されます。Ceph は、プールのイメージの種類に応じて、2 つのミラーリングモードをサポートします。

- プールモード

- ジャーナリング機能が有効になっているプール内のイメージはすべてミラーリングされます。

- イメージモード

- プール内の特定のイメージのサブセットのみがミラーリングされます。各イメージのミラーリングを別々に有効にする必要があります。

イメージの状態

イメージの変更が可能かどうかは、その状態により異なります。

- プライマリー状態のイメージを変更できます。

- プライマリー状態以外のイメージは変更できません。

イメージでミラーリングが最初に有効化された時点で、イメージはプライマリーに自動的にプロモートされます。以下でプロモートが可能です。

- プールモードでミラーリングを暗黙的に有効にする。

- 特定のイメージのミラーリングを明示的に有効にする。

プライマリーイメージをデモートし、プライマリー以外のイメージをプロモートすることができます。

関連情報

- 詳細は、Red Hat Ceph Storage ブロックデバイスガイドの イメージのプロモートとデモ セクションを参照してください。

5.3. Ansible を使用した一方向ミラーリングの設定

以下の手順では、ceph-ansible を使用して site-a と呼ばれるプライマリーストレージクラスターでイメージの一方向レプリケーションを、site-b と呼ばれるセカンダリーストレージクラスターに設定します。以下の例では、data はミラーリングされるイメージが含まれるプールの名前です。

前提条件

- Red Hat Ceph Storage クラスターを実行する 2 つ。

- Ceph クライアントノード。

- 同じ名前のプールが両方のクラスターに存在する。

- ジャーナルベースのミラーリングでは、プール内のイメージで排他的ロックとジャーナリングを有効にする必要があります。

一方向レプリケーションを使用する場合は、複数のセカンダリーストレージクラスターにミラーリングできます。

手順

イメージの元のクラスターで、イメージの排他的ロックおよびジャーナリング機能を有効にします。

新規イメージの場合は、

--image-featureオプションを使用します。構文

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME --image-feature FEATURE[,FEATURE]

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME --image-feature FEATURE[,FEATURE]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journaling

[root@rbd-client ~]# rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journalingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 既存のイメージ の場合は、

rbd feature enableコマンドを使用します。構文

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE_NAME

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd feature enable data/image1 exclusive-lock,journaling

[root@rbd-client ~]# rbd feature enable data/image1 exclusive-lock,journalingCopy to Clipboard Copied! Toggle word wrap Toggle overflow デフォルトですべての新規イメージの排他的ロックおよびジャーナリングを有効にするには、以下の設定を Ceph 設定ファイルに追加します。

rbd_default_features = 125

rbd_default_features = 125Copy to Clipboard Copied! Toggle word wrap Toggle overflow

site-aクラスターで、以下の手順を実行します。モニターノードで、

rbd-mirrorデーモンがクラスターへの接続に使用するユーザーを作成します。この例では、site-aユーザーを作成し、そのキーをsite-a.client.site-a.keyringという名前のファイルに出力します。構文

ceph auth get-or-create client.CLUSTER_NAME mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/CLUSTER_NAME.client.USER_NAME.keyring

ceph auth get-or-create client.CLUSTER_NAME mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/CLUSTER_NAME.client.USER_NAME.keyringCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

ceph auth get-or-create client.site-a mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/site-a.client.site-a.keyring

[root@mon ~]# ceph auth get-or-create client.site-a mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/site-a.client.site-a.keyringCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

Ceph 設定ファイルおよび新たに作成された鍵ファイルをモニターノードから

site-bのモニターおよびクライアントノードにコピーします。 -

Ceph 設定ファイルの名前を

ceph.confから CLUSTER-NAME.conf に変更します。この例では、ファイルは/etc/ceph/site-a.confです。

site-bクラスターで、以下の手順を実行します。-

Ansible 管理ノードで、Ansible インベントリーファイルに

[rbdmirrors]グループを追加します。通常のインベントリーファイルは/etc/ansible/hostsです。 [rbdmirrors]グループの下に、rbd-mirrorデーモンが実行されるsite-bクライアントノードの名前を追加します。デーモンは、イメージの変更をsite-aからsite-bにプルします。[rbdmirrors] ceph-client

[rbdmirrors] ceph-clientCopy to Clipboard Copied! Toggle word wrap Toggle overflow /usr/share/ceph-ansibleディレクトリーに移動します。cd /usr/share/ceph-ansible

[root@admin ~]# cd /usr/share/ceph-ansibleCopy to Clipboard Copied! Toggle word wrap Toggle overflow group_vars/rbdmirrors.yml.sampleからgroup_vars/rbdmirrors.ymlにコピーして、新しいrbdmirrors.ymlファイルを作成します。cp group_vars/rbdmirrors.yml.sample group_vars/rbdmirrors.yml

[root@admin ceph-ansible]# cp group_vars/rbdmirrors.yml.sample group_vars/rbdmirrors.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

group_vars/rbdmirrors.ymlファイルを開いて編集します。 ceph_rbd_mirror_configureをtrueに設定します。ceph_rbd_mirror_poolは、イメージをミラーリングするプールに設定します。この例では、dataはプールの名前です。ceph_rbd_mirror_configure: true ceph_rbd_mirror_pool: "data"

ceph_rbd_mirror_configure: true ceph_rbd_mirror_pool: "data"Copy to Clipboard Copied! Toggle word wrap Toggle overflow デフォルトでは、

ceph-ansibleはプール内の全イメージをミラーリングするプールモードを使用してミラーリングを設定します。ミラーリングが明示的に有効になっているイメージのみがミラーリングされるイメージモードを有効にします。イメージモードを有効にするには、ceph_rbd_mirror_modeをimageに設定します。ceph_rbd_mirror_mode: image

ceph_rbd_mirror_mode: imageCopy to Clipboard Copied! Toggle word wrap Toggle overflow rbd-mirrorがプルするクラスターの名前を設定します。以下の例では、他のクラスターはsite-aです。ceph_rbd_mirror_remote_cluster: "site-a"

ceph_rbd_mirror_remote_cluster: "site-a"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ansible 管理ノードで、

ceph_rbd_mirror_remote_userを使用してキーのユーザー名を設定します。キーの作成時に使用した同じ名前を使用します。この例では、ユーザーの名前はclient.site-aです。ceph_rbd_mirror_remote_user: "client.site-a"

ceph_rbd_mirror_remote_user: "client.site-a"Copy to Clipboard Copied! Toggle word wrap Toggle overflow ceph-ansible ユーザーとして、Ansible Playbook を実行します。

ベアメタルデプロイメント

ansible-playbook site.yml --limit rbdmirrors -i hosts

[user@admin ceph-ansible]$ ansible-playbook site.yml --limit rbdmirrors -i hostsCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンテナーデプロイメント

ansible-playbook site-container.yml --limit rbdmirrors -i hosts

[ansible@admin ceph-ansible]$ ansible-playbook site-container.yml --limit rbdmirrors -i hostsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

Ansible 管理ノードで、Ansible インベントリーファイルに

site-aクラスターとsite-bクラスターの両方で、必要なイメージのミラーリングを明示的に有効にします。構文

ジャーナルベースのミラーリング

rbd mirror image enable POOL/IMAGE

rbd mirror image enable POOL/IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow スナップショットベースのミラーリング

rbd mirror image enable POOL/IMAGE snapshot

rbd mirror image enable POOL/IMAGE snapshotCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd mirror image enable data/image1 rbd mirror image enable data/image1 snapshot

[root@mon ~]# rbd mirror image enable data/image1 [root@mon ~]# rbd mirror image enable data/image1 snapshotCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記新規イメージをピアクラスターにミラーリングする場合は常にこの手順を繰り返します。

ミラーリングのステータスを確認します。

site-bクラスターの Ceph Monitor ノードから以下のコマンドを実行します。例

ジャーナルベースのミラーリング

Copy to Clipboard Copied! Toggle word wrap Toggle overflow スナップショットベースのミラーリング

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記サイト間の接続によって、ミラーリングでイメージの同期に時間がかかる場合があります。

5.4. Ansible を使用した双方向ミラーリングの設定

この手順では、ceph-ansible を使用して双方向のレプリケーションを設定し、イメージを site-a と site-b と呼ばれる 2 つのクラスター間でミラーリングできるようにします。以下の例では、data はミラーリングされるイメージが含まれるプールの名前です。

双方向ミラーリングでは、どちらのクラスターにおいても、同じイメージへの同時書き込みはできません。イメージは一方のクラスターでプロモートされ、他方のクラスターではデモートされます。ステータスに応じて、それらは一方向または反対方向でミラリングされます。

前提条件

- Red Hat Ceph Storage クラスターを実行する 2 つ。

- 各クラスターにクライアントノードがある。

- 同じ名前のプールが両方のクラスターに存在する。

- ジャーナルベースのミラーリングでは、プール内のイメージで排他的ロックとジャーナリングを有効にする必要があります。

手順

イメージの元のクラスターで、イメージの排他的ロックおよびジャーナリング機能を有効にします。

新規イメージの場合は、

--image-featureオプションを使用します。構文

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME --image-feature FEATURE[,FEATURE]

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME --image-feature FEATURE[,FEATURE]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journaling

[root@rbd-client ~]# rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journalingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 既存のイメージ の場合は、

rbd feature enableコマンドを使用します。構文

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE_NAME

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd feature enable data/image1 exclusive-lock,journaling

[root@rbd-client ~]# rbd feature enable data/image1 exclusive-lock,journalingCopy to Clipboard Copied! Toggle word wrap Toggle overflow デフォルトですべての新規イメージの排他的ロックおよびジャーナリングを有効にするには、以下の設定を Ceph 設定ファイルに追加します。

rbd_default_features = 125

rbd_default_features = 125Copy to Clipboard Copied! Toggle word wrap Toggle overflow

site-aクラスターで、以下の手順を実行します。モニターノードで、

rbd-mirrorデーモンがクラスターへの接続に使用するユーザーを作成します。この例では、site-aユーザーを作成し、そのキーをsite-a.client.site-a.keyringという名前のファイルに出力します。Ceph 設定ファイルは/etc/ceph/site-a.confです。構文

ceph auth get-or-create client.PRIMARY_CLUSTER_NAME mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/PRIMARY_CLUSTER_NAME.client.USER_NAME.keyring -c /etc/ceph/PRIMARY_CLUSTER_NAME.conf

ceph auth get-or-create client.PRIMARY_CLUSTER_NAME mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/PRIMARY_CLUSTER_NAME.client.USER_NAME.keyring -c /etc/ceph/PRIMARY_CLUSTER_NAME.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

ceph auth get-or-create client.site-a mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/site-a.client.site-a.keyring -c /etc/ceph/site-a.conf

[root@mon ~]# ceph auth get-or-create client.site-a mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/site-a.client.site-a.keyring -c /etc/ceph/site-a.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow キーリングは

site-bクラスターにコピーします。rbd-daemonが実行されるsite-bクラスターのクライアントノードにファイルをコピーします。このファイルを/etc/ceph/site-a.client.site-a.keyringに保存します。構文

scp /etc/ceph/PRIMARY_CLUSTER_NAME.client.USER_NAME.keyring root@SECONDARY_CLIENT_NODE_NAME:/etc/ceph/PRIMARY_CLUSTER_NAME.client.USER_NAME.keyring

scp /etc/ceph/PRIMARY_CLUSTER_NAME.client.USER_NAME.keyring root@SECONDARY_CLIENT_NODE_NAME:/etc/ceph/PRIMARY_CLUSTER_NAME.client.USER_NAME.keyringCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

scp /etc/ceph/site-a.client.site-a.keyring root@client.site-b:/etc/ceph/site-a.client.site-a.keyring

[root@mon ~]# scp /etc/ceph/site-a.client.site-a.keyring root@client.site-b:/etc/ceph/site-a.client.site-a.keyringCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph 設定ファイルをモニターノードから

site-bモニターノードおよびクライアントノードにコピーします。この例の Ceph 設定ファイルは/etc/ceph/site-a.confです。構文

scp /etc/ceph/PRIMARY_CLUSTER_NAME.conf root@SECONDARY_MONITOR_NODE_NAME:/etc/ceph/PRIMARY_CLUSTER_NAME.conf scp /etc/ceph/PRIMARY_CLUSTER_NAME.conf user@SECONDARY_CLIENT_NODE_NAME:/etc/ceph/PRIMARY_CLUSTER_NAME.conf

scp /etc/ceph/PRIMARY_CLUSTER_NAME.conf root@SECONDARY_MONITOR_NODE_NAME:/etc/ceph/PRIMARY_CLUSTER_NAME.conf scp /etc/ceph/PRIMARY_CLUSTER_NAME.conf user@SECONDARY_CLIENT_NODE_NAME:/etc/ceph/PRIMARY_CLUSTER_NAME.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

scp /etc/ceph/site-a.conf root@mon.site-b:/etc/ceph/site-a.conf scp /etc/ceph/site-a.conf user@client.site-b:/etc/ceph/site-a.conf

[root@mon ~]# scp /etc/ceph/site-a.conf root@mon.site-b:/etc/ceph/site-a.conf [root@mon ~]# scp /etc/ceph/site-a.conf user@client.site-b:/etc/ceph/site-a.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow

site-bクラスターで、以下の手順を実行します。-

site-aからsite-bへのミラーリングを設定します。Ansible 管理ノードで、rbdmirrorsグループを Ansible インベントリーファイル (通常は/usr/share/ceph-ansible/hosts) に追加します。 [rbdmirrors]グループの下に、rbd-mirrorデーモンが実行されるsite-bクライアントノードの名前を追加します。このデーモンは、イメージの変更をsite-aからsite-bにプルします。例

[rbdmirrors] client.site-b

[rbdmirrors] client.site-bCopy to Clipboard Copied! Toggle word wrap Toggle overflow /usr/share/ceph-ansibleディレクトリーに移動します。cd /usr/share/ceph-ansible

[root@admin ~]$ cd /usr/share/ceph-ansibleCopy to Clipboard Copied! Toggle word wrap Toggle overflow group_vars/rbdmirrors.yml.sampleからgroup_vars/rbdmirrors.ymlにコピーして、新しいrbdmirrors.ymlファイルを作成します。cp group_vars/rbdmirrors.yml.sample group_vars/rbdmirrors.yml

[root@admin ceph-ansible]# cp group_vars/rbdmirrors.yml.sample group_vars/rbdmirrors.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

group_vars/rbdmirrors.ymlファイルを開いて編集します。 ceph_rbd_mirror_configureをtrueに設定し、ceph_rbd_mirror_poolをイメージをミラーリングするプールに設定します。この例では、dataはプールの名前です。ceph_rbd_mirror_configure: true ceph_rbd_mirror_pool: "data"

ceph_rbd_mirror_configure: true ceph_rbd_mirror_pool: "data"Copy to Clipboard Copied! Toggle word wrap Toggle overflow デフォルトでは、

ceph-ansibleはプール内の全イメージをミラーリングするプールモードを使用してミラーリングを設定します。ミラーリングが明示的に有効になっているイメージのみがミラーリングされるイメージモードを有効にします。イメージモードを有効にするには、ceph_rbd_mirror_modeをimageに設定します。ceph_rbd_mirror_mode: image

ceph_rbd_mirror_mode: imageCopy to Clipboard Copied! Toggle word wrap Toggle overflow group_vars/rbdmirrors.ymlファイルにrbd-mirrorのクラスターの名前を設定します。以下の例では、他のクラスターはsite-aです。ceph_rbd_mirror_remote_cluster: "site-a"

ceph_rbd_mirror_remote_cluster: "site-a"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ansible 管理ノードで、

group_vars/rbdmirrors.ymlファイルのceph_rbd_mirror_remote_userを使用してキーのユーザー名を設定します。キーの作成時に使用した同じ名前を使用します。この例では、ユーザーの名前はclient.site-aです。ceph_rbd_mirror_remote_user: "client.site-a"

ceph_rbd_mirror_remote_user: "client.site-a"Copy to Clipboard Copied! Toggle word wrap Toggle overflow ansible ユーザーとして、Ansible Playbook を実行します。

ベアメタルデプロイメント

ansible-playbook site.yml --limit rbdmirrors -i hosts

[user@admin ceph-ansible]$ ansible-playbook site.yml --limit rbdmirrors -i hostsCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンテナーデプロイメント

ansible-playbook site-container.yml --limit rbdmirrors -i hosts

[user@admin ceph-ansible]$ ansible-playbook site-container.yml --limit rbdmirrors -i hostsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

ミラーリングのステータスを確認します。

site-bクラスターで、Ceph Monitor ノードから以下のコマンドを実行します。例

ジャーナルベースのミラーリング

Copy to Clipboard Copied! Toggle word wrap Toggle overflow スナップショットベースのミラーリング

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記サイト間の接続によって、ミラーリングでイメージの同期に時間がかかる場合があります。

site-bクラスターで、以下の手順を実行します。手順は上記とほぼ同じです。モニターノードで、

rbd-mirrorデーモンがクラスターへの接続に使用するユーザーを作成します。この例では、site-bユーザーを作成し、そのキーをsite-b.client.site-b.keyringという名前のファイルに出力します。Ceph 設定ファイルは/etc/ceph/site-b.confです。構文

ceph auth get-or-create client.SECONDARY_CLUSTER_NAME mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/SECONDARY_CLUSTER_NAME.client.USER_NAME.keyring -c /etc/ceph/SECONDARY_CLUSTER_NAME.conf

ceph auth get-or-create client.SECONDARY_CLUSTER_NAME mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/SECONDARY_CLUSTER_NAME.client.USER_NAME.keyring -c /etc/ceph/SECONDARY_CLUSTER_NAME.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

ceph auth get-or-create client.site-b mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/site-b.client.site-b.keyring -c /etc/ceph/site-b.conf

[root@mon ~]# ceph auth get-or-create client.site-b mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/site-b.client.site-b.keyring -c /etc/ceph/site-b.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow キーリングを

site-aクラスターにコピーします。rbd-daemonが実行されるsite-aクラスターのクライアントノードにファイルをコピーします。ファイルを/etc/ceph/site-b.client.site-b.keyringに保存します。構文

scp /etc/ceph/SECONDARY_CLUSTER_NAME.client.USER_NAME.keyring root@PRIMARY_CLIENT_NODE_NAME:/etc/ceph/SECONDARY_CLUSTER_NAME.client.USER_NAME.keyring

scp /etc/ceph/SECONDARY_CLUSTER_NAME.client.USER_NAME.keyring root@PRIMARY_CLIENT_NODE_NAME:/etc/ceph/SECONDARY_CLUSTER_NAME.client.USER_NAME.keyringCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

scp /etc/ceph/site-b.client.site-b.keyring root@client.site-a:/etc/ceph/site-b.client.site-b.keyring

[root@mon ~]# scp /etc/ceph/site-b.client.site-b.keyring root@client.site-a:/etc/ceph/site-b.client.site-b.keyringCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph 設定ファイルをモニターノードから

site-aモニターノードおよびクライアントノードにコピーします。この例の Ceph 設定ファイルは/etc/ceph/site-b.confです。構文

scp /etc/ceph/SECONDARY_CLUSTER_NAME.conf root@PRIMARY_MONITOR_NODE_NAME:/etc/ceph/SECONDARY_CLUSTER_NAME.conf scp /etc/ceph/SECONDARY_CLUSTER_NAME.conf user@PRIMARY_CLIENT_NODE_NAME:/etc/ceph/SECONDARY_CLUSTER_NAME.conf

scp /etc/ceph/SECONDARY_CLUSTER_NAME.conf root@PRIMARY_MONITOR_NODE_NAME:/etc/ceph/SECONDARY_CLUSTER_NAME.conf scp /etc/ceph/SECONDARY_CLUSTER_NAME.conf user@PRIMARY_CLIENT_NODE_NAME:/etc/ceph/SECONDARY_CLUSTER_NAME.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

scp /etc/ceph/site-b.conf root@mon.site-a:/etc/ceph/site-b.conf scp /etc/ceph/site-b.conf user@client.site-a:/etc/ceph/site-b.conf

[root@mon ~]# scp /etc/ceph/site-b.conf root@mon.site-a:/etc/ceph/site-b.conf [root@mon ~]# scp /etc/ceph/site-b.conf user@client.site-a:/etc/ceph/site-b.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow

site-aクラスターで、以下の手順を実行します。-

site-bからsite-aへのミラーリングを設定します。Ansible 管理ノードで、rbdmirrorsグループを Ansible インベントリーファイル (通常は/usr/share/ceph-ansible/hosts) に追加します。 [rbdmirrors]グループの下に、rbd-mirrorデーモンが実行されるsite-aクライアントノードの名前を追加します。このデーモンは、イメージの変更をsite-bからsite-aにプルします。例

[rbdmirrors] client.site-a

[rbdmirrors] client.site-aCopy to Clipboard Copied! Toggle word wrap Toggle overflow /usr/share/ceph-ansibleディレクトリーに移動します。cd /usr/share/ceph-ansible

[root@admin ~]# cd /usr/share/ceph-ansibleCopy to Clipboard Copied! Toggle word wrap Toggle overflow group_vars/rbdmirrors.yml.sampleからgroup_vars/rbdmirrors.ymlにコピーして、新しいrbdmirrors.ymlファイルを作成します。cp group_vars/rbdmirrors.yml.sample group_vars/rbdmirrors.yml

[root@admin ceph-ansible]# cp group_vars/rbdmirrors.yml.sample group_vars/rbdmirrors.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

group_vars/rbdmirrors.ymlファイルを開いて編集します。 ceph_rbd_mirror_configureをtrueに設定し、ceph_rbd_mirror_poolをイメージをミラーリングするプールに設定します。この例では、dataはプールの名前です。ceph_rbd_mirror_configure: true ceph_rbd_mirror_pool: "data"

ceph_rbd_mirror_configure: true ceph_rbd_mirror_pool: "data"Copy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: デフォルトでは、

ceph-ansibleはプール内の全イメージをミラーリングするプールモードを使用してミラーリングを設定します。ミラーリングが明示的に有効になっているイメージのみがミラーリングされるイメージモードを有効にします。イメージモードを有効にするには、ceph_rbd_mirror_modeをimageに設定します。ceph_rbd_mirror_mode: image

ceph_rbd_mirror_mode: imageCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ansible 管理ノードで、

group_vars/rbdmirrors.ymlファイルにrbd-mirrorクラスターの名前を設定します。例に従い、その他のクラスターの名前はsite-bとします。ceph_rbd_mirror_remote_cluster: "site-b"

ceph_rbd_mirror_remote_cluster: "site-b"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ansible 管理ノードで、

group_vars/rbdmirrors.ymlファイルのceph_rbd_mirror_remote_userを使用してキーのユーザー名を設定します。この例では、ユーザーの名前はclient.site-bです。ceph_rbd_mirror_remote_user: "client.site-b"

ceph_rbd_mirror_remote_user: "client.site-b"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 管理ノードで Ansible ユーザーとして、Ansible Playbook を実行します。

ベアメタルデプロイメント

ansible-playbook site.yml --limit rbdmirrors -i hosts

[user@admin ceph-ansible]$ ansible-playbook site.yml --limit rbdmirrors -i hostsCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンテナーデプロイメント

ansible-playbook site-container.yml --limit rbdmirrors -i hosts

[user@admin ceph-ansible]$ ansible-playbook site-container.yml --limit rbdmirrors -i hostsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

site-aクラスターとsite-bクラスターの両方で、必要なイメージのミラーリングを明示的に有効にします。構文

ジャーナルベースのミラーリング

rbd mirror image enable POOL/IMAGE

rbd mirror image enable POOL/IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow スナップショットベースのミラーリング

rbd mirror image enable POOL/IMAGE snapshot

rbd mirror image enable POOL/IMAGE snapshotCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd mirror image enable data/image1 rbd mirror image enable data/image1 snapshot

[root@mon ~]# rbd mirror image enable data/image1 [root@mon ~]# rbd mirror image enable data/image1 snapshotCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記新規イメージをピアクラスターにミラーリングする場合は常にこの手順を繰り返します。

ミラーリングのステータスを確認します。

site-aクラスターのクライアントノードから以下のコマンドを実行します。例

ジャーナルベースのミラーリング

Copy to Clipboard Copied! Toggle word wrap Toggle overflow スナップショットベースのミラーリング

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.5. コマンドラインインターフェイスを使用した一方向ミラーリングの設定

この手順では、プライマリーストレージクラスターからセカンダリーストレージクラスターへのプールの一方向レプリケーションを設定します。

一方向レプリケーションを使用する場合は、複数のセカンダリーストレージクラスターにミラーリングできます。

このセクションの例には、プライマリーイメージでプライマリーストレージクラスターを site-a として、そのイメージをレプリケートするセカンダリーストレージクラスターを site-b として参照し、2 つのストレージクラスターを区別します。これらの例で使用されるプール名は data と呼ばれます。

前提条件

- 少なくとも、正常に実行されている Red Hat Ceph Storage クラスター 2 台。

- 各ストレージクラスターの Ceph クライアントノードへの Root レベルのアクセス。

- 管理者レベル権限が割り当てられた CephX ユーザー。

- ジャーナルベースのミラーリングでは、プール内のイメージで排他的ロックとジャーナリングを有効にする必要があります。

手順

site-bストレージクラスターに接続されているクライアントノードにrbd-mirrorパッケージをインストールします。Red Hat Enterprise Linux 7

yum install rbd-mirror

[root@rbd-client ~]# yum install rbd-mirrorCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 8

dnf install rbd-mirror

[root@rbd-client ~]# dnf install rbd-mirrorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記パッケージは Red Hat Ceph Storage Tools リポジトリーによって提供されます。

イメージ上で排他的ロックおよびジャーナリング機能を有効にします。

新規イメージの場合は、

--image-featureオプションを使用します。構文

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME --image-feature FEATURE [,FEATURE]

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME --image-feature FEATURE [,FEATURE]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journaling

[root@rbd-client ~]# rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journalingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 既存のイメージ の場合は、

rbd feature enableコマンドを使用します。構文

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE [,FEATURE]

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE [,FEATURE]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd feature enable data/image1 exclusive-lock,journaling

[root@rbd-client ~]# rbd feature enable data/image1 exclusive-lock,journalingCopy to Clipboard Copied! Toggle word wrap Toggle overflow デフォルトですべての新規イメージの排他的ロックおよびジャーナリングを有効にするには、以下の設定を Ceph 設定ファイルに追加します。

rbd_default_features = 125

rbd_default_features = 125Copy to Clipboard Copied! Toggle word wrap Toggle overflow

ミラーリングモード (pool または image モード) を選択します。

重要スナップショットベースのミラーリングには、イメージモードを使用します。

プールモード の有効化:

構文

rbd mirror pool enable POOL_NAME MODE

rbd mirror pool enable POOL_NAME MODECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd mirror pool enable data pool

[root@rbd-client ~]# rbd mirror pool enable data poolCopy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

dataという名前のプール全体のミラーリングを有効にします。イメージモード の有効化:

構文

rbd mirror pool enable POOL_NAME MODE

rbd mirror pool enable POOL_NAME MODECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd mirror pool enable data image

[root@rbd-client ~]# rbd mirror pool enable data imageCopy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

dataという名前のプールでイメージモードのミラーリングを有効にします。ミラーリングが正常に有効になっていることを確認します。

構文

rbd mirror pool info POOL_NAME

rbd mirror pool info POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd mirror pool info data Mode: image Site Name: 94cbd9ca-7f9a-441a-ad4b-52a33f9b7148 Peer Sites: none

[root@rbd-client ~]# rbd mirror pool info data Mode: image Site Name: 94cbd9ca-7f9a-441a-ad4b-52a33f9b7148 Peer Sites: noneCopy to Clipboard Copied! Toggle word wrap Toggle overflow

site-aクラスターで、以下の手順を実行します。Ceph クライアントノードで、ユーザーを作成します。

構文

ceph auth get-or-create client.PRIMARY_CLUSTER_NAME mon 'profile rbd-mirror' osd 'profile rbd' -o /etc/ceph/ceph.PRIMARY_CLUSTER_NAME.keyring

ceph auth get-or-create client.PRIMARY_CLUSTER_NAME mon 'profile rbd-mirror' osd 'profile rbd' -o /etc/ceph/ceph.PRIMARY_CLUSTER_NAME.keyringCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

ceph auth get-or-create client.rbd-mirror.site-a mon 'profile rbd-mirror' osd 'profile rbd' -o /etc/ceph/ceph.client.rbd-mirror.site-a.keyring

[root@rbd-client-site-a ~]# ceph auth get-or-create client.rbd-mirror.site-a mon 'profile rbd-mirror' osd 'profile rbd' -o /etc/ceph/ceph.client.rbd-mirror.site-a.keyringCopy to Clipboard Copied! Toggle word wrap Toggle overflow キーリングを

site-bクラスターにコピーします。構文

scp /etc/ceph/ceph.PRIMARY_CLUSTER_NAME.keyring root@SECONDARY_CLUSTER:_PATH_

scp /etc/ceph/ceph.PRIMARY_CLUSTER_NAME.keyring root@SECONDARY_CLUSTER:_PATH_Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

scp /etc/ceph/ceph.client.rbd-mirror.site-a.keyring root@rbd-client-site-b:/etc/ceph/

[root@rbd-client-site-a ~]# scp /etc/ceph/ceph.client.rbd-mirror.site-a.keyring root@rbd-client-site-b:/etc/ceph/Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph クライアントノードで、ストレージクラスターのピアをブートストラップします。

ストレージクラスターのピアをプールに登録します。

構文

rbd mirror pool peer bootstrap create --site-name LOCAL_SITE_NAME POOL_NAME > PATH_TO_BOOTSTRAP_TOKEN

rbd mirror pool peer bootstrap create --site-name LOCAL_SITE_NAME POOL_NAME > PATH_TO_BOOTSTRAP_TOKENCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd mirror pool peer bootstrap create --site-name rbd-mirror.site-a data > /root/bootstrap_token_rbd-mirror.site-a

[root@rbd-client-site-a ~]# rbd mirror pool peer bootstrap create --site-name rbd-mirror.site-a data > /root/bootstrap_token_rbd-mirror.site-aCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記bootstrap コマンドの例では、

client.rbd-mirror-peerCeph ユーザーを作成します。ブートストラップトークンファイルを

site-bストレージクラスターにコピーします。構文