Dashboard ガイド

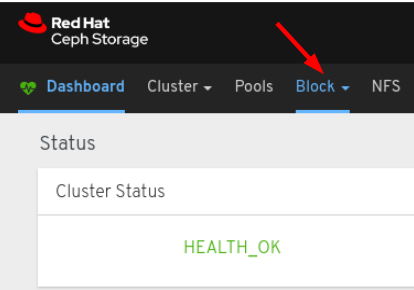

Ceph Dashboard を使用した Ceph クラスターのモニタリング

概要

第1章 Ceph Dashboard の概要

ストレージ管理者は、Red Hat Ceph Storage Dashboard は管理機能および監視機能を提供します。これにより、クラスターの管理および設定が可能になり、それに関連する情報およびパフォーマンス統計を可視化を可能にします。ダッシュボードは、ceph-mgr デーモンがホストする Web サーバーを使用します。

ダッシュボードは Web ブラウザーからアクセスでき、たとえばマネージャーモジュールの設定や OSD の状態の監視などの有用な管理機能および監視機能が含まれます。

1.1. 前提条件

- システム管理者レベルの経験

1.2. ダッシュボードコンポーネント

ダッシュボードの機能は複数のコンポーネントで提供されます。

- デプロイメント用の Ansible 自動化アプリケーション。

-

埋め込みダッシュボードである

ceph-mgrモジュール。 -

埋め込み Prometheus である

ceph-mgrモジュール。 - Prometheus の時系列データベース。

- ストレージクラスターの各ノードで実行される Prometheus の node-exporter デーモン。

- 監視ユーザーインターフェイスおよびアラートを提供する Grafana プラットフォーム。

関連情報

- 詳細は、Ansible の Web サイト を参照してください。

- 詳細は、Prometheus の Web サイト を参照してください。

- 詳細は、Grafana の Web サイト を参照してください。

1.3. Dashboard の機能

Ceph Dashboard は複数の機能を提供します。

管理機能

- クラスターの階層の表示: CRUSH マップを表示できます。たとえば、特定の OSD ID が実行されているノードを判別できます。これは、OSD に問題がある場合に便利です。

- マネージャーモジュールの設定: Ceph マネージャーモジュールのパラメーターを表示および変更できます。

- ログの表示および絞り込み: イベントおよび監査クラスターのログを表示し、優先順位、キーワード、日付、または時間範囲に基づいてフィルタリングできます。

- ダッシュボードコンポーネントの切り替え: ダッシュボードのコンポーネントを有効および無効にできるため、必要な機能のみが利用可能になります。

- OSD 設定の管理: ダッシュボードを使用してクラスター全体の OSD フラグを設定できます。

- アラートの表示 アラートページでは、現在のアラートの詳細を表示できます。

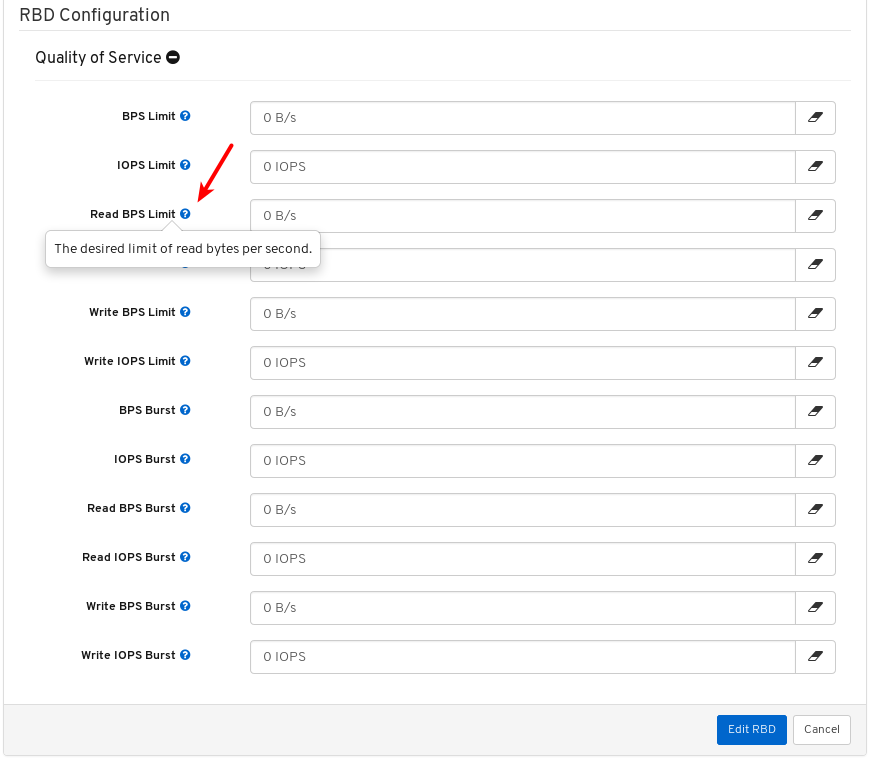

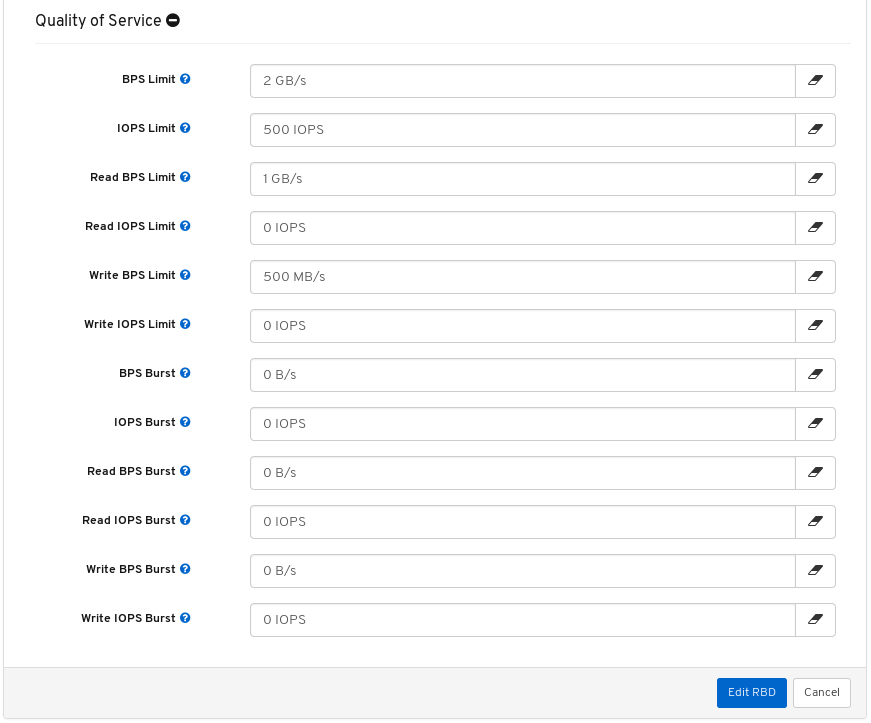

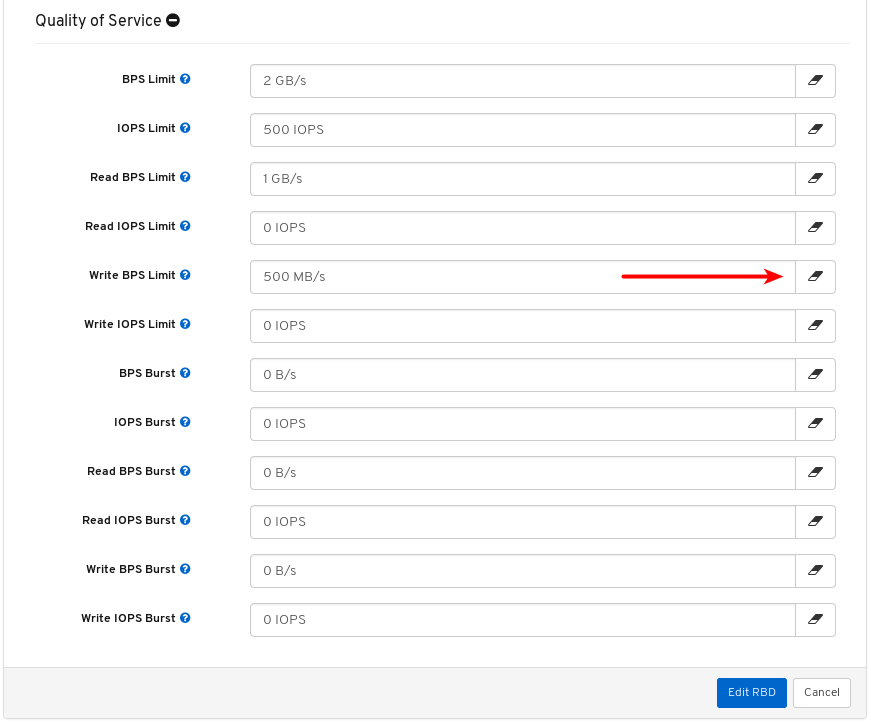

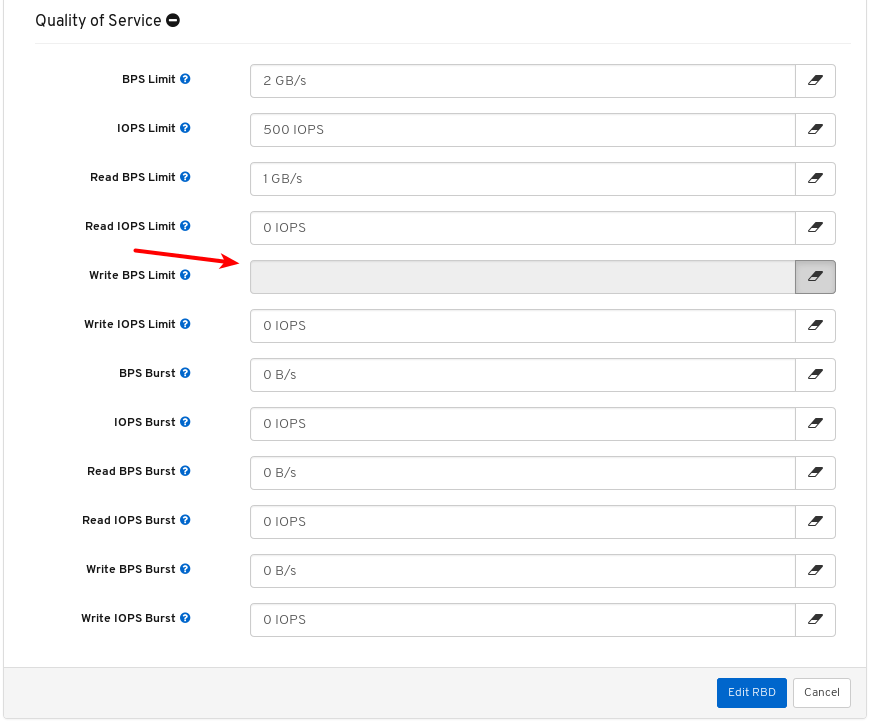

- イメージのサービス品質: IOPS の制限や、BPS バーストレートの読み取りなど、イメージにパフォーマンス制限を設定できます。

監視機能

- ユーザー名およびパスワード保護: 設定可能なユーザー名とパスワードのみを使用してダッシュボードにアクセスできます。

SSL および TLS のサポート: Web ブラウザーとダッシュボード間の HTTP 通信はすべて SSL 経由で保護されます。自己署名証明書は組み込みコマンドで作成できますが、認証局 (CA) が署名して発行したカスタム証明書をインポートすることもできます。Red Hat Ceph Storage 4.2 以降、

dashboard_protocolはhttpsに設定され、Ansible はダッシュボードと grafana 証明書を生成します。データポイントとグラフをプロットするには、以下のように TLS ハンドシェイクを手動で更新します。- Alert manager API host - http://grafana_node:9093

- Prometheus API host - http://grafana_node:9092

- Grafana API Host - https://grafana_node:3000

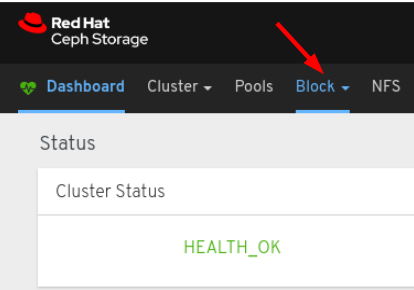

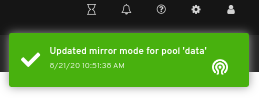

- クラスター全体の正常性: クラスター全体のステータス、ストレージ使用率 (オブジェクトの数、Raw 容量、プールごとの使用量など)、プールのリストおよびそれらのステータスと使用状況の統計を表示します。

- ホスト: 実行中のサービスおよびインストールされた Ceph バージョンと共に、クラスターに関連付けられたホストの一覧を提供します。

- パフォーマンスカウンター: 実行中の各サービスの詳細統計を表示します。

- モニター: モニター、クォーラムのステータス、およびオープンセッションの一覧を表示します。

- 設定リファレンス: 利用可能な設定オプション、その説明、デフォルト値の一覧を表示します。

- クラスターログ: クラスターのイベントおよび監査ログを表示し、フィルタリングします。

- ストレージクラスターの容量の表示: Red Hat Ceph Storage クラスターの Raw ストレージ容量は、Ceph Dashboard の Capacity パネルで確認できます。

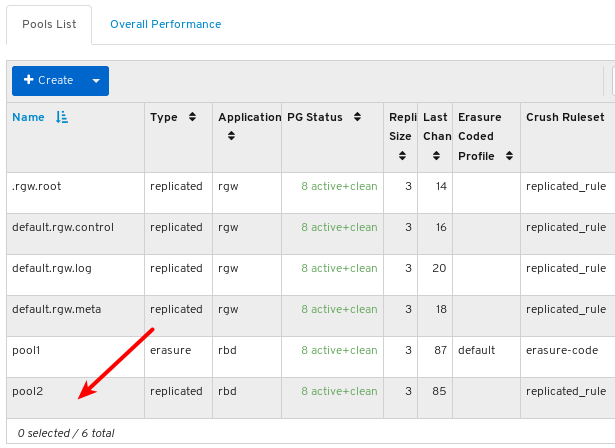

- Pools: すべての Ceph プールとその詳細を一覧表示および管理します。たとえば、アプリケーション、配置グループ、レプリケーションサイズ、EC プロファイル、CRUSH ルールセットなどです。

- OSD: すべての OSD、それらのステータスおよび使用状況の統計に加えて、属性 (OSD マップ)、メタデータ、パフォーマンスカウンター、読み取り/書き込み操作のためのヒストグラムなどの詳細情報を一覧表示および管理します。

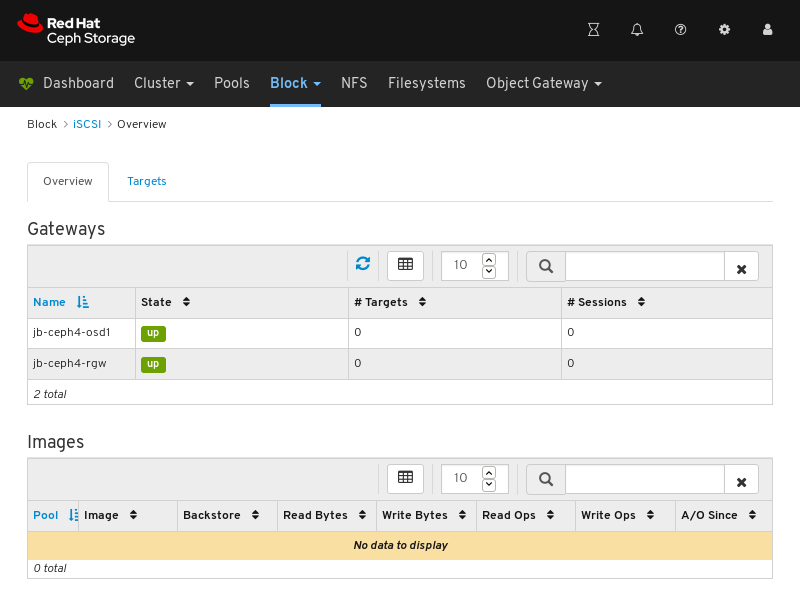

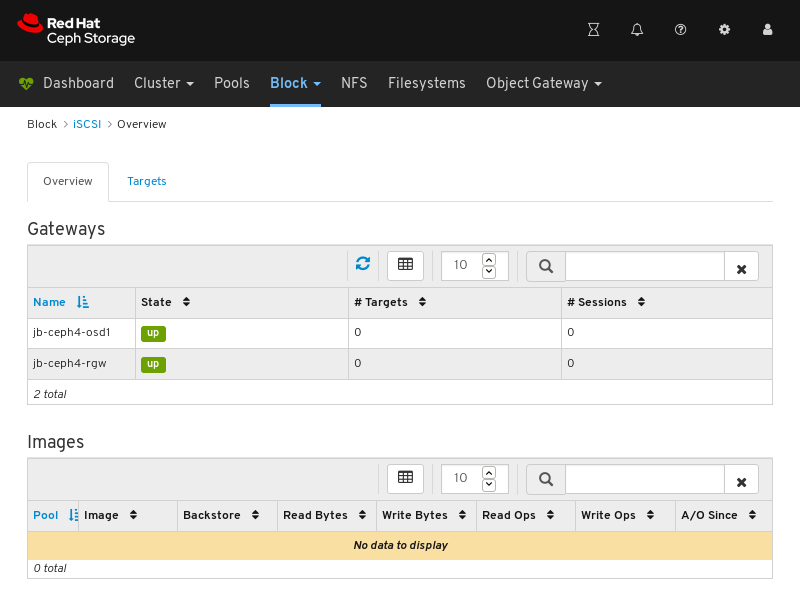

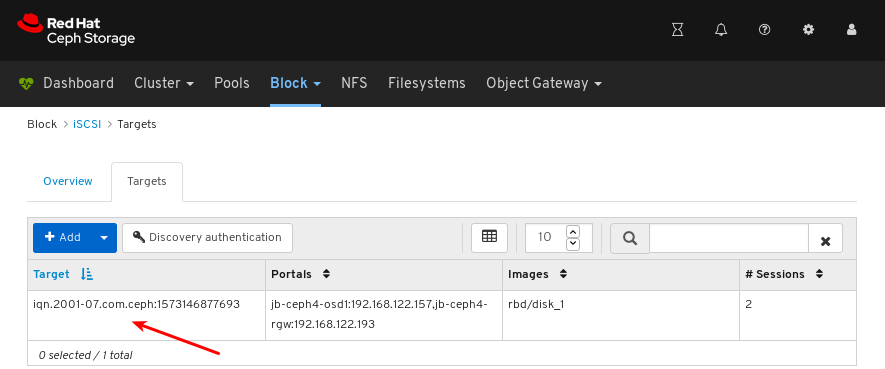

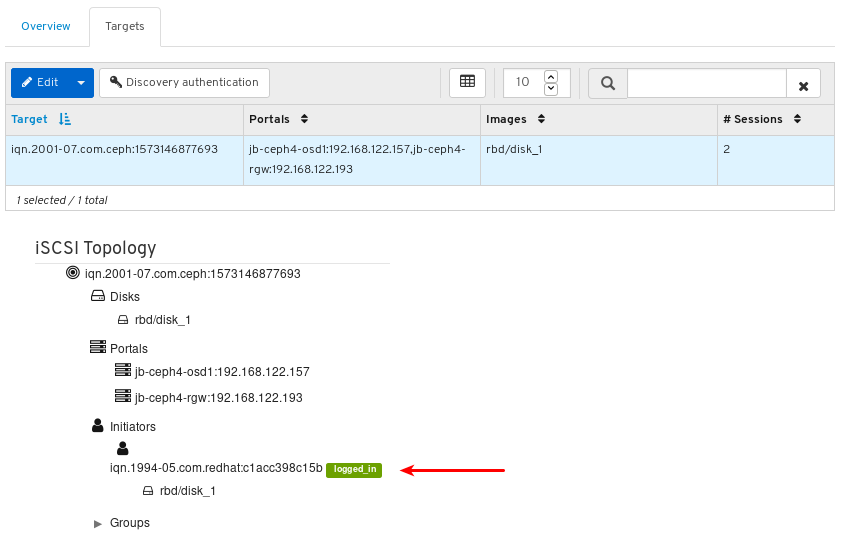

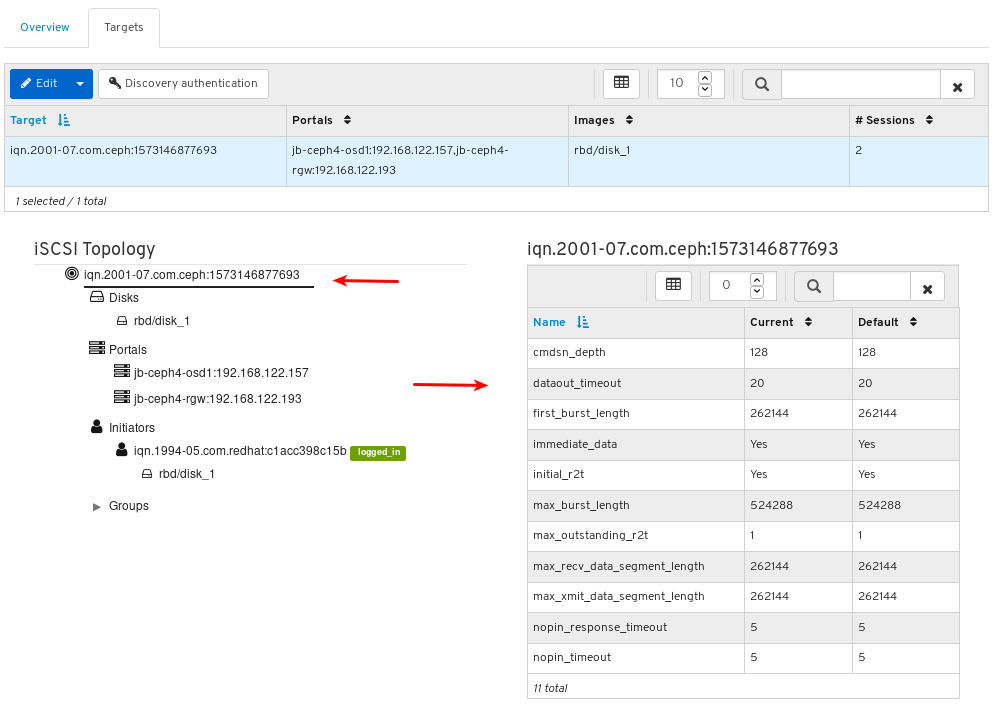

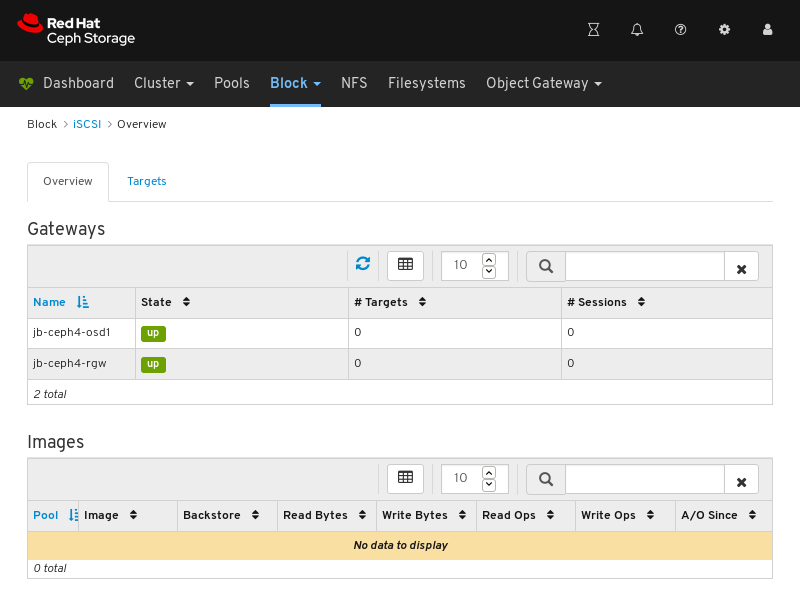

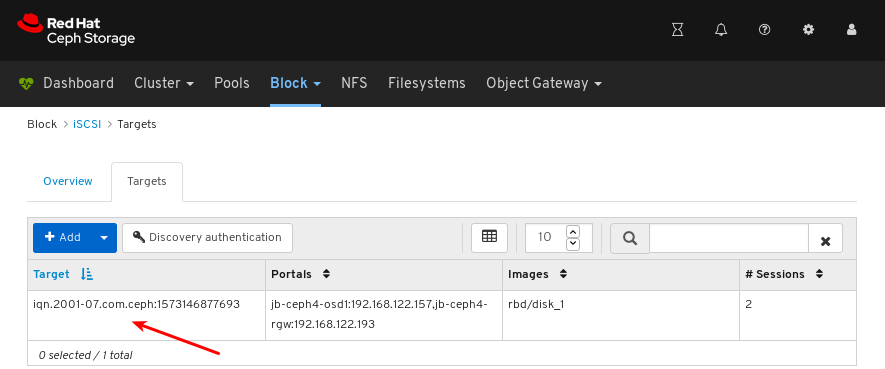

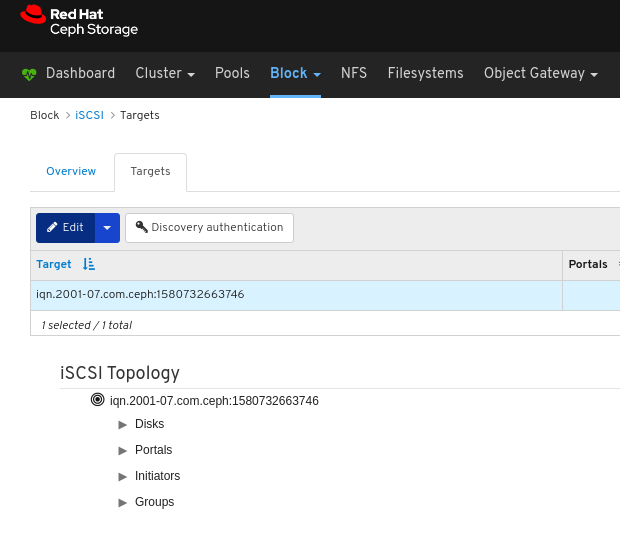

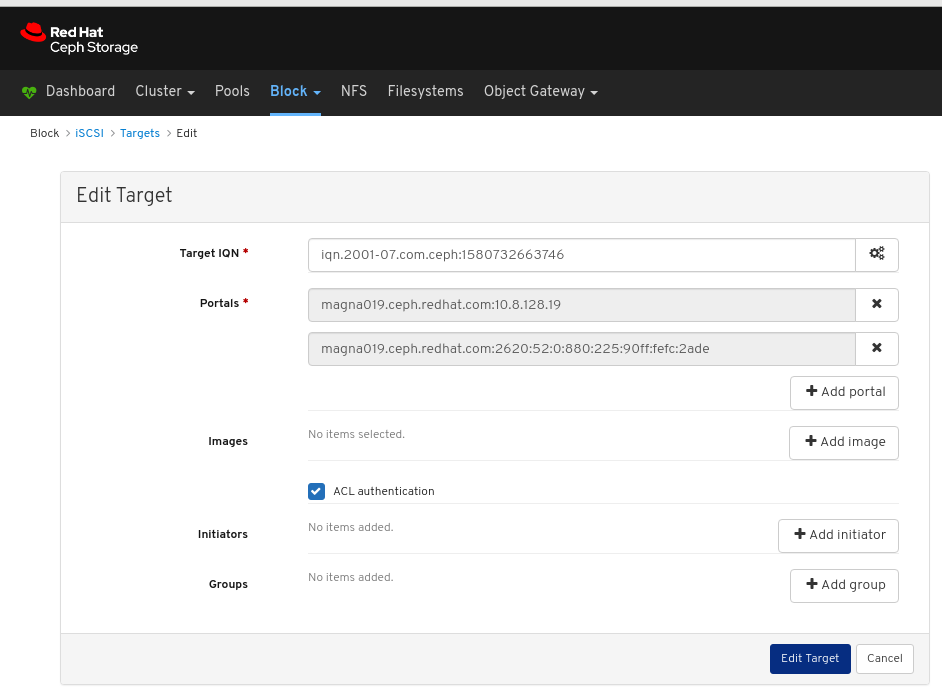

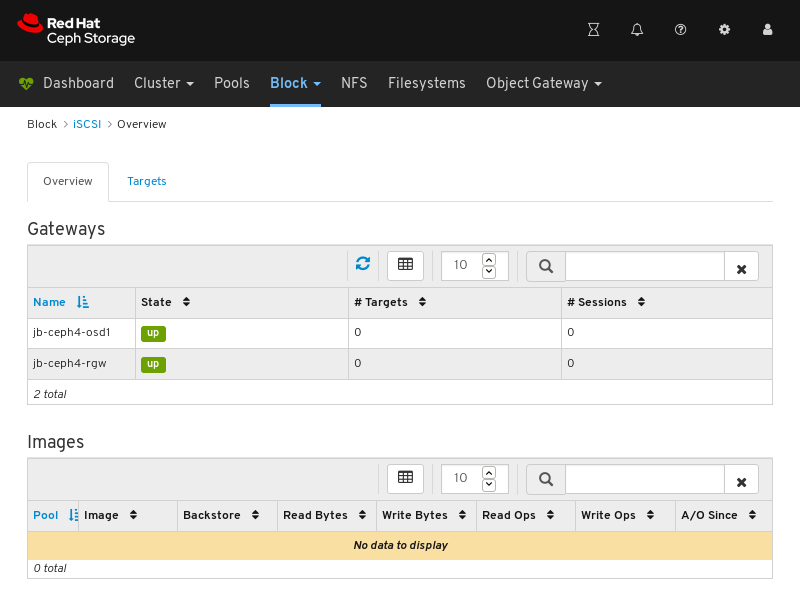

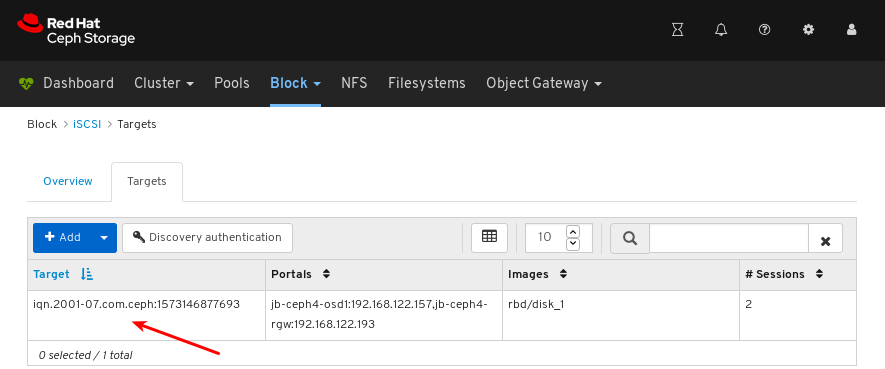

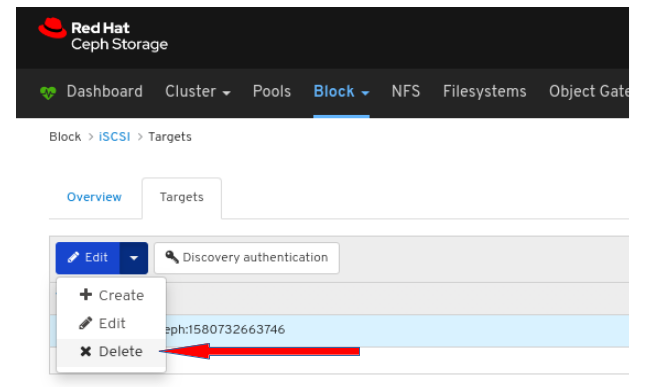

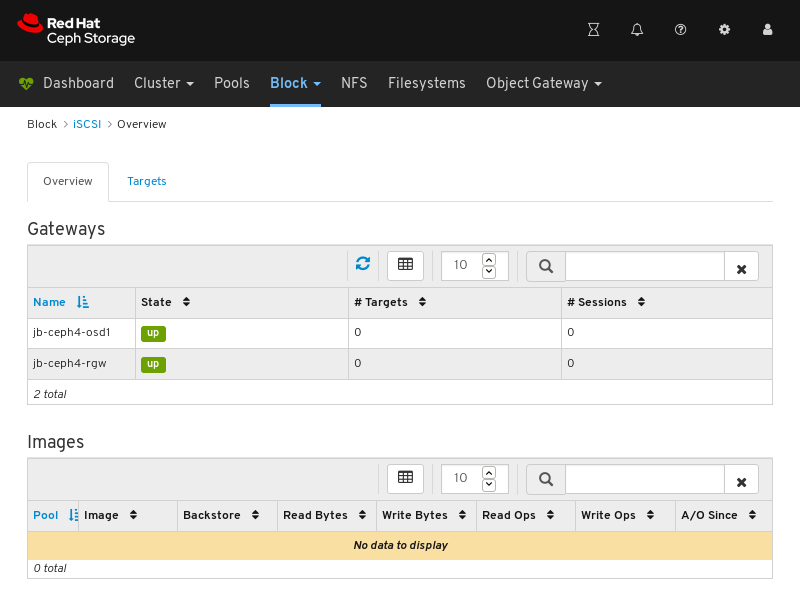

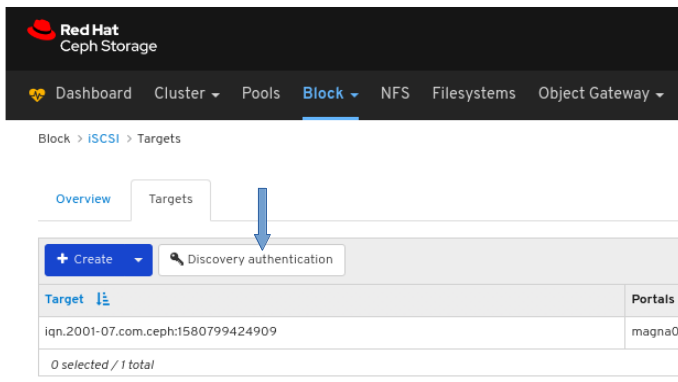

- iSCSI: tcmu-runner サービスを実行するホストの一覧を表示し、読み取り/書き込み操作やトラフィックなど、すべてのイメージとそのパフォーマンスの特性を表示します。

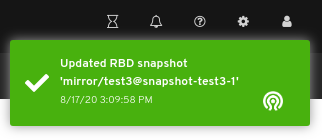

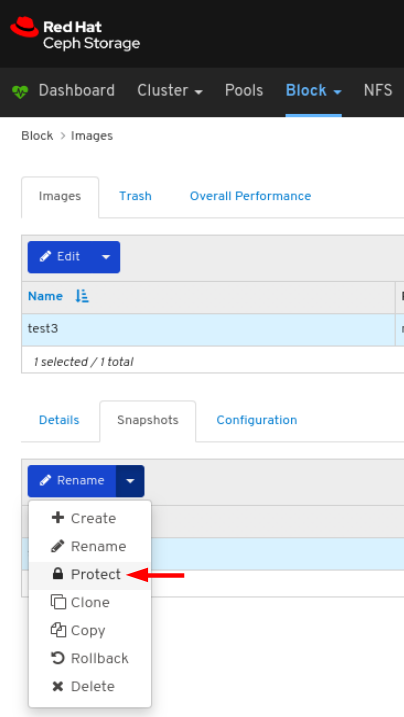

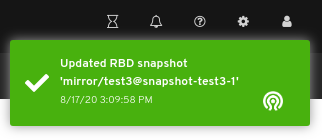

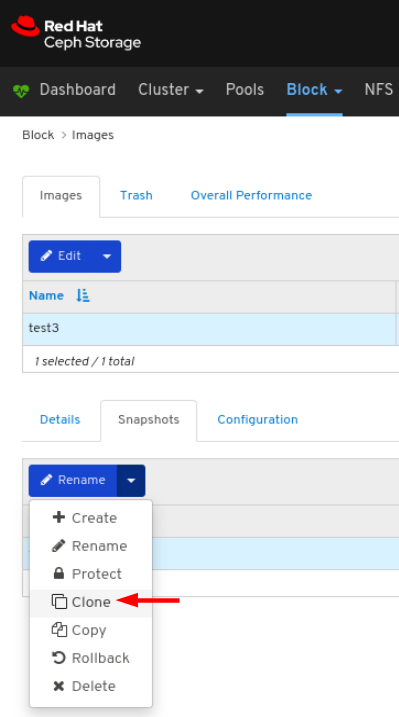

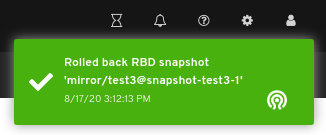

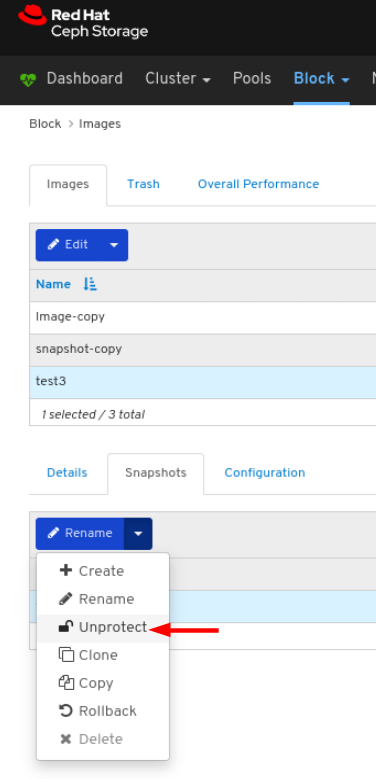

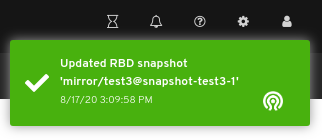

イメージ: サイズ、オブジェクト、機能などのすべての RBD イメージと、そのプロパティーを表示します。RBD イメージの作成、コピー、変更、および削除を行います。選択したイメージのスナップショットを作成、削除、およびロールバックし、変更に対してこのスナップショットを保護するか、保護を解除します。スナップショットをコピーまたは複製し、複製されたイメージを平坦化します。

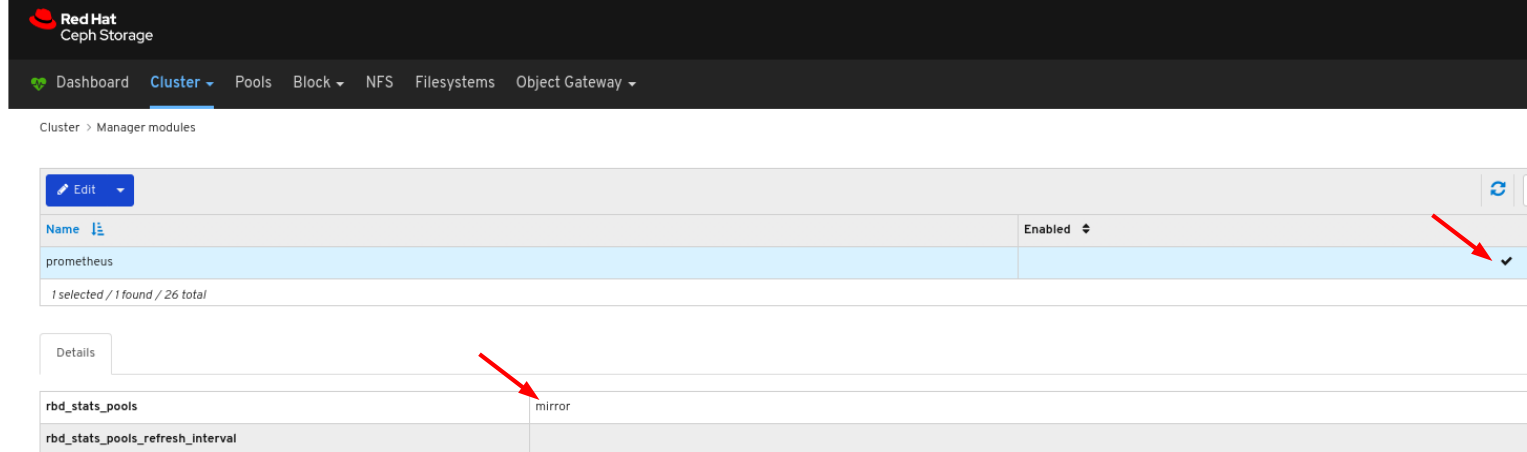

注記特定のイメージの Overall Performance タブの I/O 変更のパフォーマンスグラフには、Cluster > Manager modules > Prometheus の

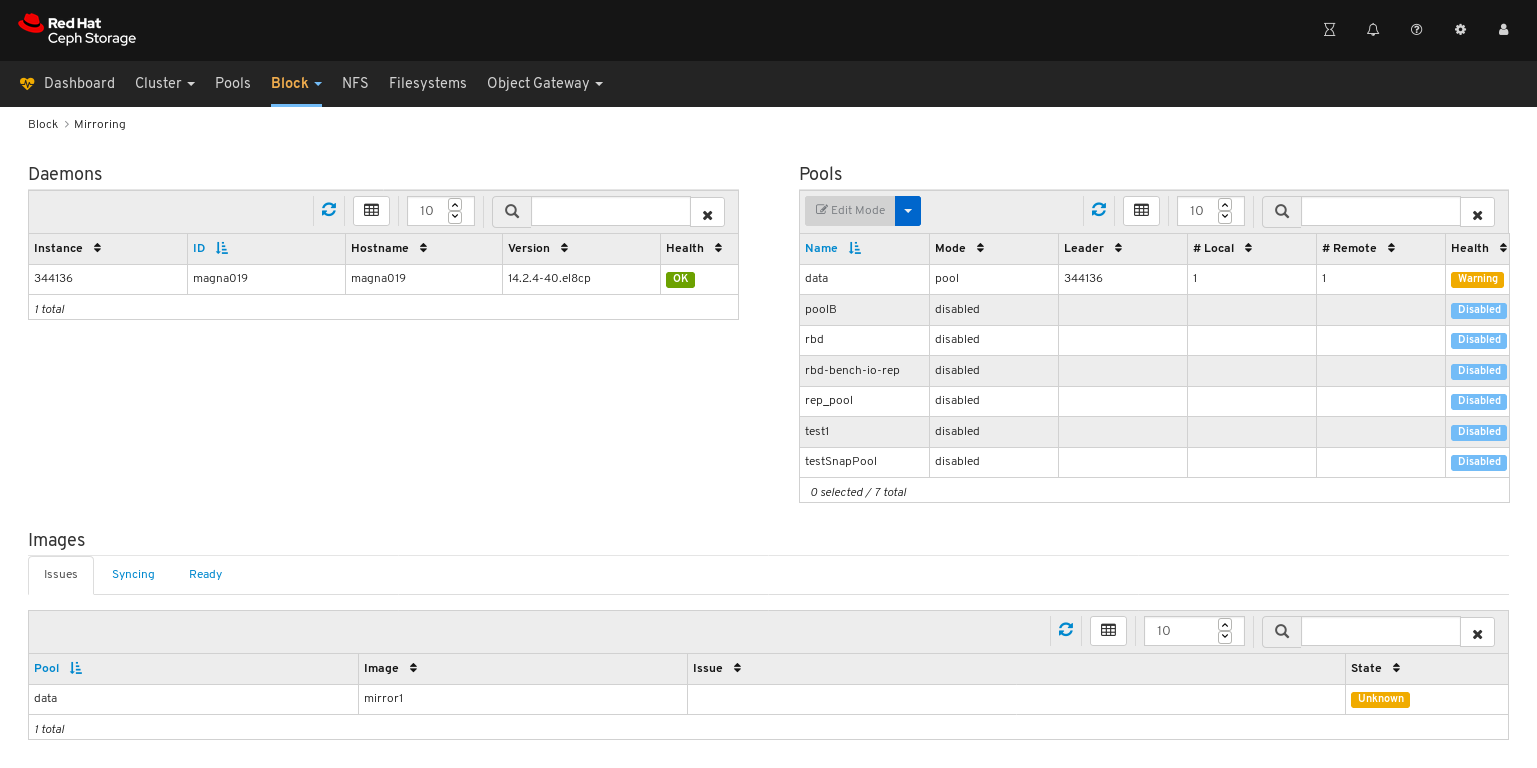

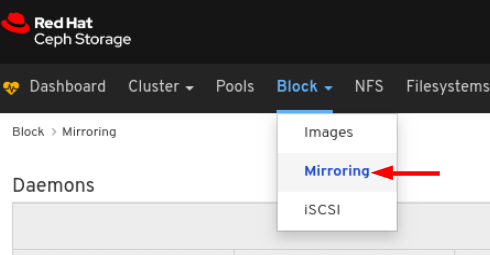

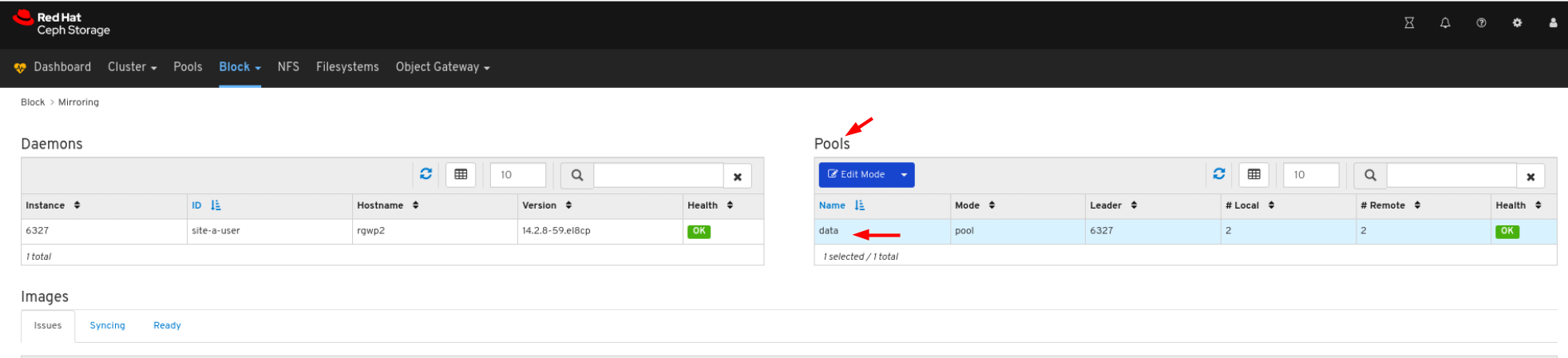

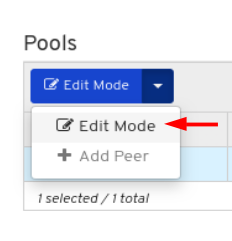

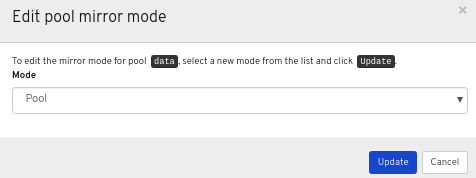

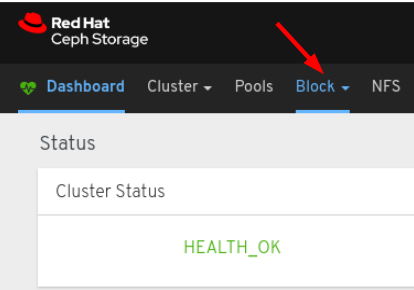

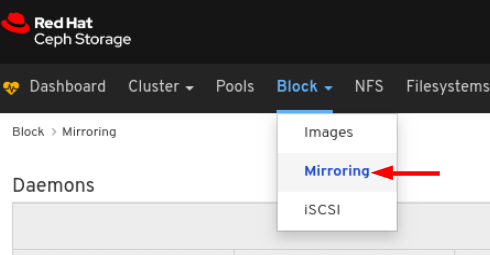

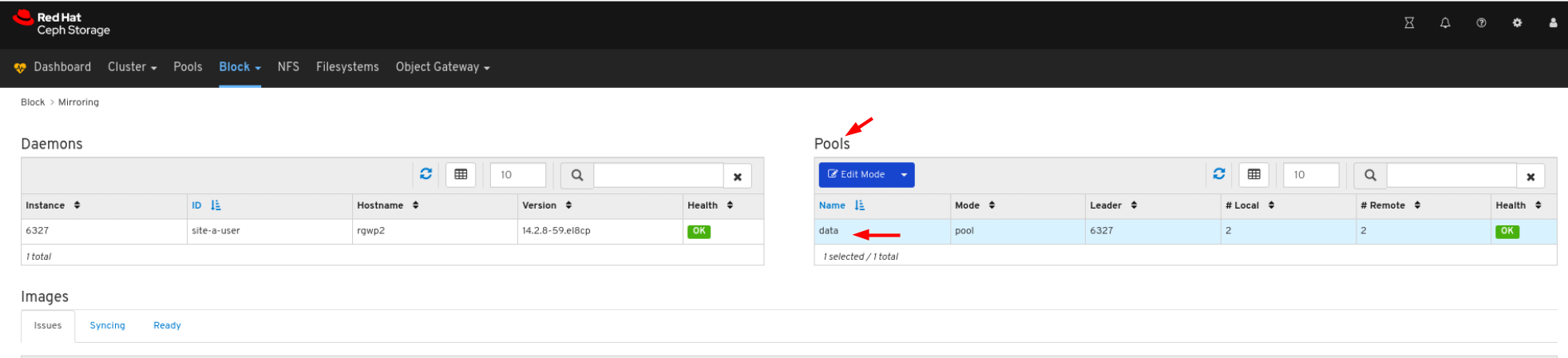

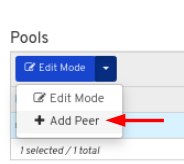

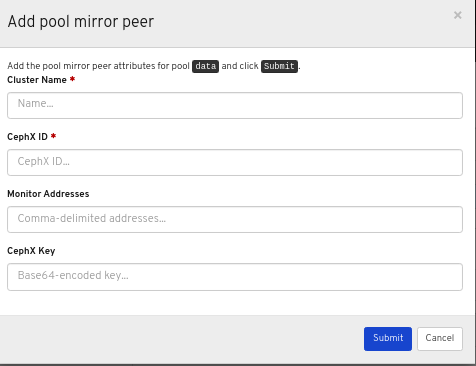

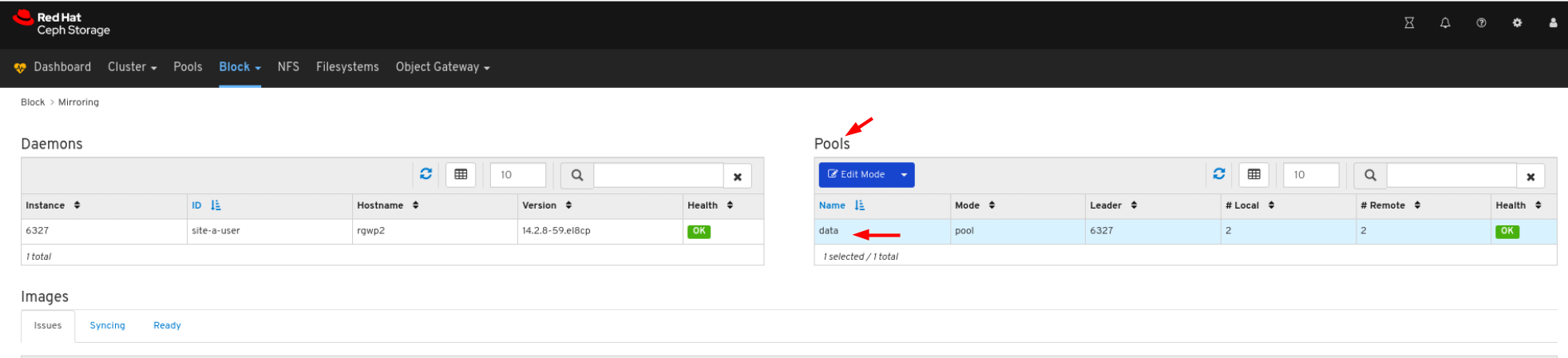

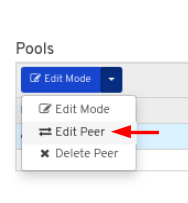

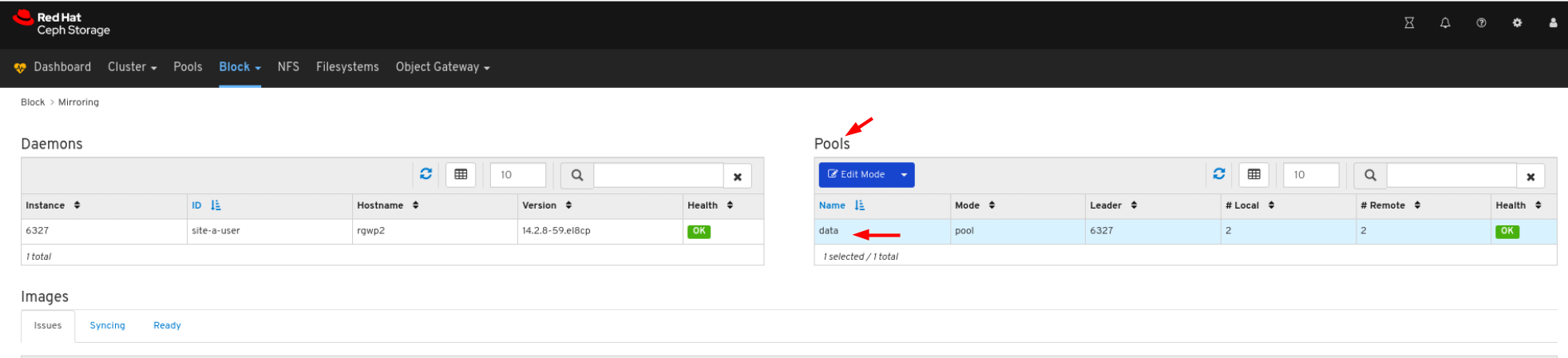

rbd_stats_poolパラメーターを設定すると、そのイメージを含むプールを指定した後にのみ値が表示されます。- ミラーリング: 同期状態を含む、すべてのアクティブな同期デーモンとそのステータス、プール、および RBD イメージの一覧を表示します。

- ファイルシステム: アクティブな Ceph ファイルシステム (CephFS) クライアントと関連するプール (使用状況の統計を含む) の一覧を表示します。

- Object Gateway (RGW): アクティブなすべてのObject Gateway とそのパフォーマンスカウンターを表示します。Object Gateway ユーザーの表示および管理 (追加、編集、削除) およびその詳細 (クォータなど)、ユーザーのバケットおよびその詳細 (例: 所有者、クォータなど) を表示および管理します。

関連情報

- 詳細は、Red Hat Ceph Storage ダッシュボードガイドの ダッシュボードコンポーネントの on と off の切り替え を参照してください。

1.3.1. ダッシュボード機能のオンとオフの切り替え

オンデマンドで機能を有効または無効にすることで、Red Hat Ceph Storage ダッシュボードのコンポーネントをカスタマイズできます。デフォルトでは、すべての機能が有効になっています。機能を無効にすると、Web インターフェイス要素は非表示になり、関連付けられた REST API のエンドポイントはその機能に対する追加のリクエストを拒否します。ダッシュボード機能の有効化および無効化は、コマンドラインインターフェイスまたは Web インターフェイスから実行できます。

利用可能な機能:

Ceph ブロックデバイス:

-

イメージの管理 (

rbd) -

ミラーリング (

mirroring) -

iSCSI ゲートウェイ (

iscsi)

-

イメージの管理 (

-

Ceph ファイルシステム (

cephfs) -

Ceph Object Gateway (

rgw)

デフォルトでは、Ceph Manager は Ceph Monitor と併置されます。

複数の機能を一度に無効にできます。

機能が無効になったら、Web インターフェイスの変更を反映するのに最大 20 秒かかる場合があります。

前提条件

- Red Hat Ceph Storage ダッシュボードソフトウェアのインストールおよび設定

- Ceph Manager ノードまたはダッシュボードの Web インターフェイスへのユーザーアクセス

手順

ダッシュボードの Web インターフェイスからダッシュボード機能を切り替えるには、以下を実行します。

- ダッシュボードページのナビゲーションバーから Cluster に移動し、Manager Modules に移動してから Dashboard をクリックします。これにより、Edit Manager モジュール ページが開きます。

Edit Manager module ページから、機能名の横にある選択ボックスを選択するか、選択を解除すると、ダッシュボードの機能を有効または無効にすることができます。

選択が完了したら、ページ下部の Update ボタンをクリックします。

コマンドラインインターフェイスからダッシュボード機能を切り替えるには、以下を実行します。

- Ceph Manager ノードにログインします。

機能のステータスの一覧を表示します。

ceph dashboard feature status

[user@mon ~]$ ceph dashboard feature statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow 機能を無効にします。

ceph dashboard feature disable iscsi

[user@mon ~]$ ceph dashboard feature disable iscsiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例では、Ceph iSCSI ゲートウェイ機能を無効にします。

機能を有効にします。

ceph dashboard feature enable cephfs

[user@mon ~]$ ceph dashboard feature enable cephfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例では、Ceph Filesystem 機能を有効にします。

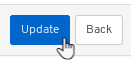

1.4. Dashboard アーキテクチャー

Dashboard アーキテクチャーは、Ceph Manager のダッシュボードプラグインおよびその他のコンポーネントによって異なります。以下の図を参照し、どのように連携するかを確認します。

第2章 Ceph Dashboard のインストールおよびアクセス

システム管理者は、ダッシュボードをインストールして初めてアクセスすることができます。

Red Hat Ceph Storage は、Cockpit Web インターフェイスを使用してグラフィックにインストールするか、ceph-ansible RPM が提供する Ansible Playbook を使用してコマンドラインにインストールされます。Cockpit で同じ Ansible Playbook を使用して Ceph をインストールします。これらの Playbook により、デフォルトでダッシュボードがインストールされます。したがって、Ansible Playbook を直接使用するか、Cockpit を使用して Ceph をインストールするかどうかに関わらず、ダッシュボードがインストールされます。

デフォルトのダッシュボードパスワードを変更します。デフォルトでは、ダッシュボードのパスワードは p@ssw0rd で、安全ではありません。Playbook を使用して Ceph をインストールする前に、Ansible Playbook の all.yml で dashboard_admin_password を更新するか、同じ Playbook またはダッシュボード自体を使用してインストールした後に、Ceph をインストールする前にデフォルトのパスワードを変更できます。詳細は、インストールガイド の ダッシュボードを使用したダッシュボードパスワードの変更 または Ansible を使用したダッシュボードのパスワードの変更 を参照してください。

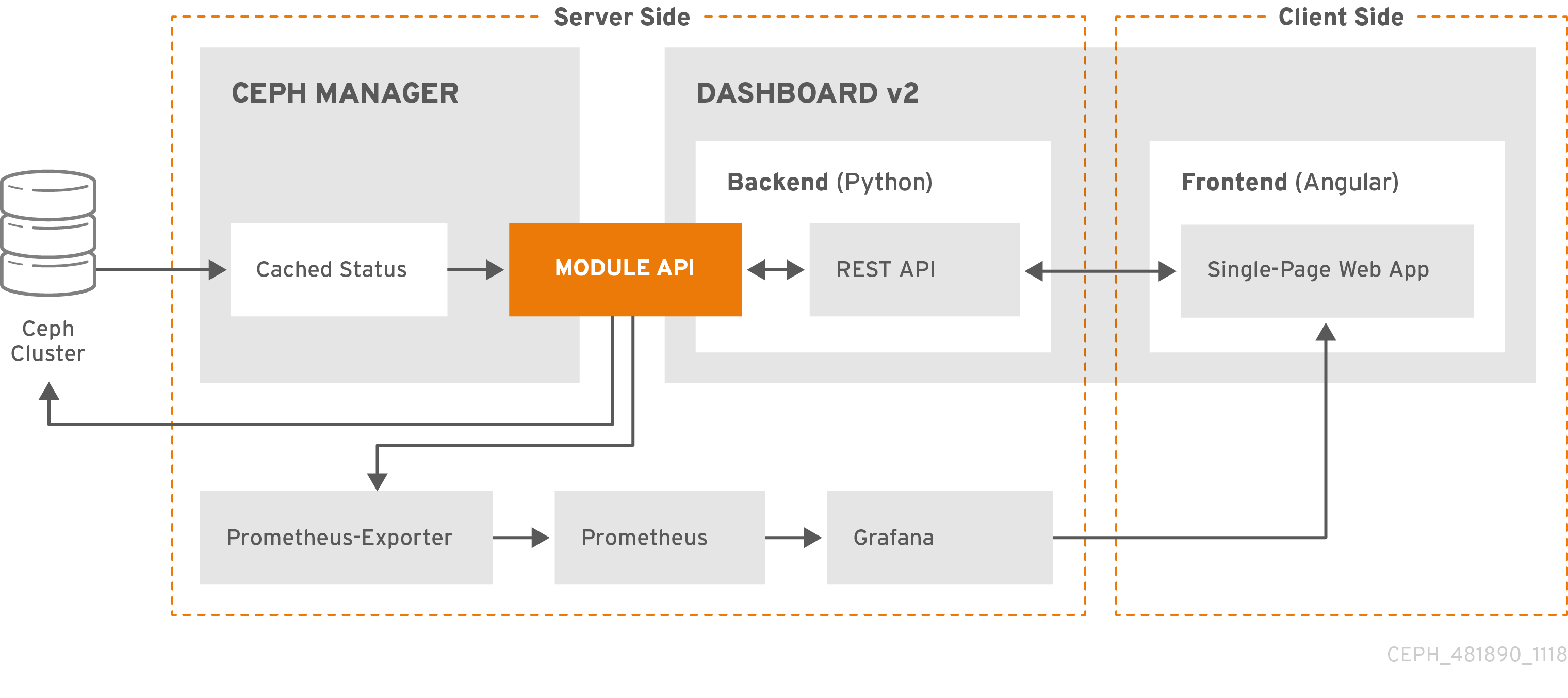

2.1. Cockpit を使用したダッシュボードのインストール

Red Hat Ceph Storage のインストールに Cockpit Web インターフェイスを使用する場合、Dashboard はデフォルトでインストールされます。Grafana のインストールには Metrics ロールを持つホストを設定する必要があります。

前提条件

- 完全な前提条件は インストールガイド を参照してください。この手順では、ダッシュボードのインストールに関連する手順のみを強調しています。

手順

Hosts ページでホストを追加し、Metrics ロールを設定します。

- Add をクリックします。

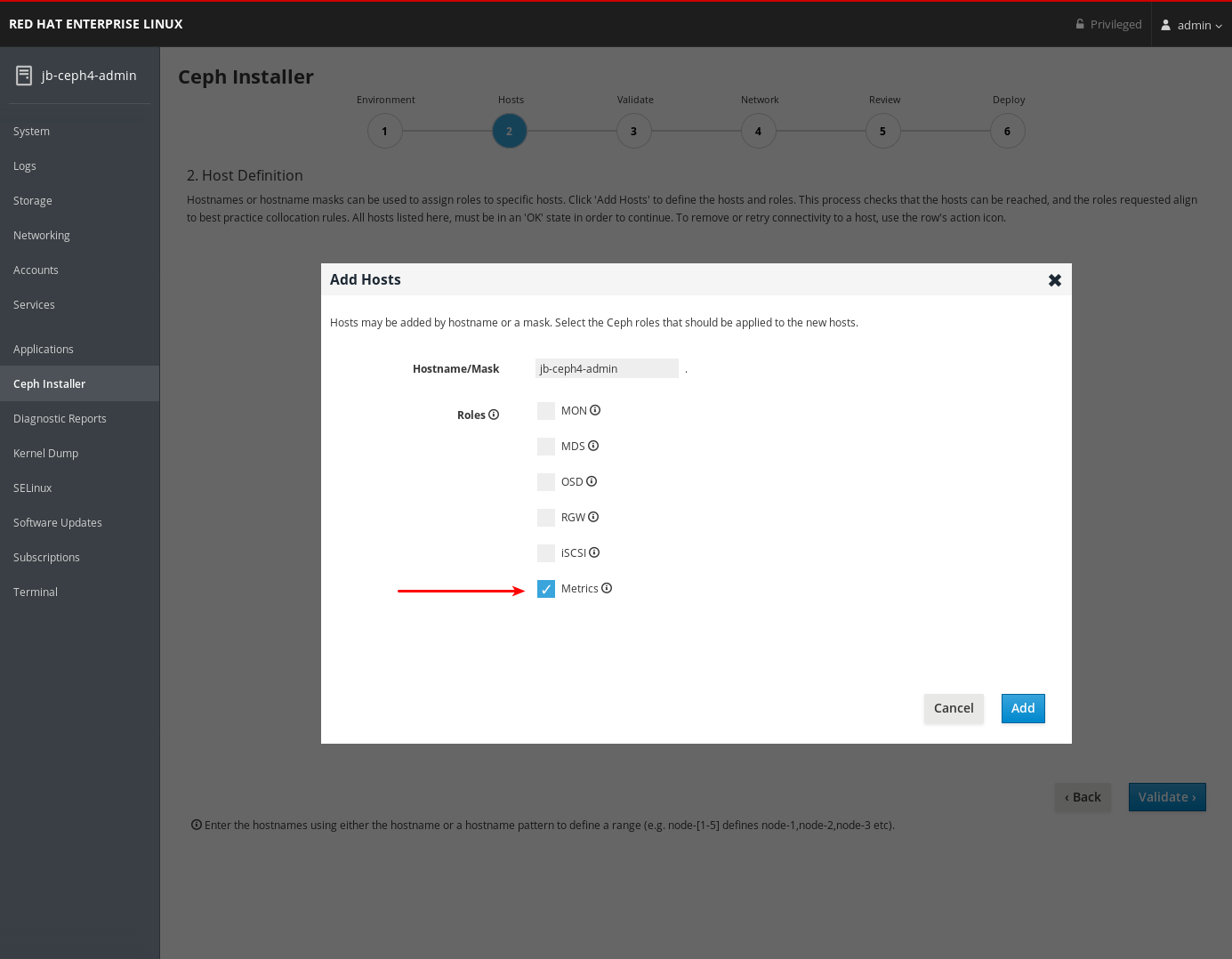

- 残りの Cockpit Ceph Installer の名前変更プロンプトを完了します。

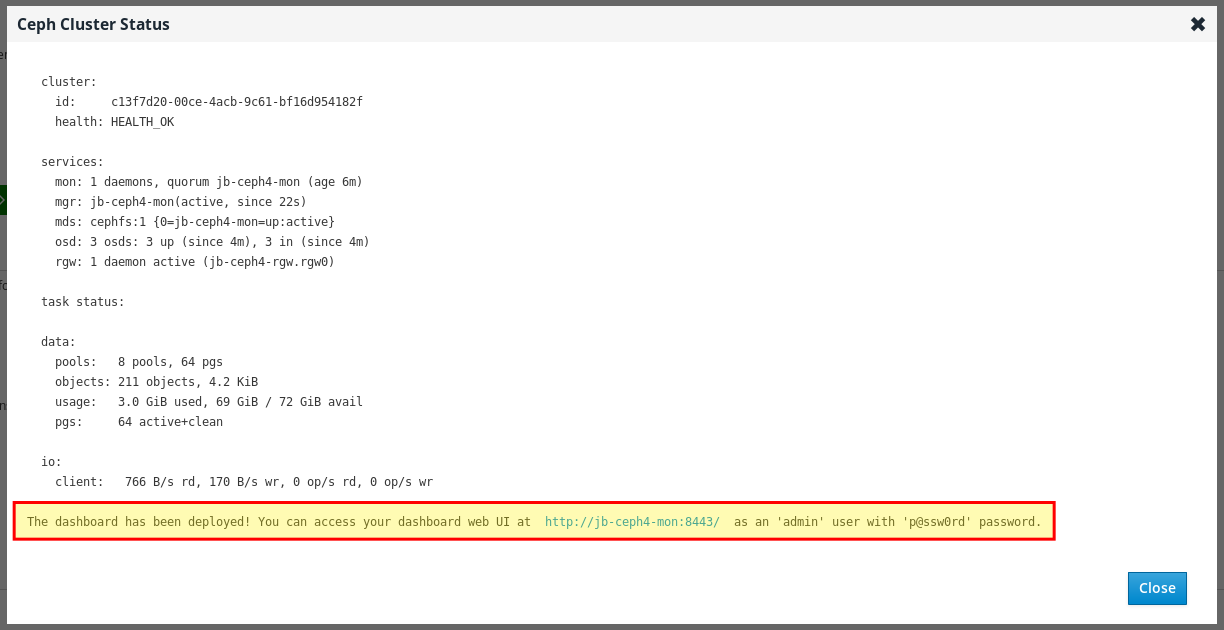

デプロイプロセスが完了したら、ページの右下隅にある Complete ボタンをクリックします。これにより、

ceph statusコマンドの出力と Dashboard のアクセス情報を表示するウィンドウが開きます。

Ceph Cluster Status ウィンドウ下部に、URL、ユーザー名、パスワードなど、Dashboard のアクセス情報が表示されます。この情報を書き留めておいてください。

- 詳細は、インストールガイド の Cockpit Web ユーザーインターフェイスを使用した Red Hat Ceph Storage のインストール を参照してください。

2.2. Ansible を使用したダッシュボードのインストール

ダッシュボードは、ceph-ansible RPM が提供する Ansible Playbook を使用して Red Hat Ceph Storage をインストールする際にデフォルトでインストールされます。

前提条件

- 完全な前提条件は インストールガイド を参照してください。この手順では、ダッシュボードのインストールに関連する手順のみを強調しています。

手順

その下でノードが定義された

[grafana-server]グループが Ansible インベントリーファイルに存在することを確認します。Grafana と Prometheus がこのノードにインストールされている。grep grafana-server -A 1 /etc/ansible/hosts [grafana-server] jb-ceph4-mon

[root@jb-ceph4-admin ~]# grep grafana-server -A 1 /etc/ansible/hosts [grafana-server] jb-ceph4-monCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ansible Playbook の

all.ymlで、Dashboard_enabled:がFalseに設定されていないことを確認します。デフォルト設定がTrueを示すコメントがなければなりません。grep "dashboard_enabled" /usr/share/ceph-ansible/group_vars/all.yml #dashboard_enabled: True

[root@jb-ceph4-admin ~]# grep "dashboard_enabled" /usr/share/ceph-ansible/group_vars/all.yml #dashboard_enabled: TrueCopy to Clipboard Copied! Toggle word wrap Toggle overflow - インストールガイド e で説明されているように、Ceph をインストールするために必要な残りの手順を実施します。

ベアメタルのインストール用に

ansible-playbook site.ymlを実行した後、コンテナーインストールの場合はansible-playbook site-docker.ymlを実行すると、Ansible によりダッシュボードのアクセス情報が出力されます。Playbook 出力の最後にあるダッシュボードの URL、ユーザー名、およびパスワードを検索します。2019-12-13 15:31:17,871 p=11421 u=admin | TASK [ceph-dashboard : print dashboard URL] ************************************************************ 2019-12-13 15:31:17,871 p=11421 u=admin | task path: /usr/share/ceph-ansible/roles/ceph-dashboard/tasks/main.yml:5 2019-12-13 15:31:17,871 p=11421 u=admin | Friday 13 December 2019 15:31:17 -0500 (0:00:02.189) 0:04:25.380 ******* 2019-12-13 15:31:17,934 p=11421 u=admin | ok: [jb-ceph4-mon] => msg: The dashboard has been deployed! You can access your dashboard web UI at http://jb-ceph4-mon:8443/ as an 'admin' user with 'p@ssw0rd' password.

2019-12-13 15:31:17,871 p=11421 u=admin | TASK [ceph-dashboard : print dashboard URL] ************************************************************ 2019-12-13 15:31:17,871 p=11421 u=admin | task path: /usr/share/ceph-ansible/roles/ceph-dashboard/tasks/main.yml:5 2019-12-13 15:31:17,871 p=11421 u=admin | Friday 13 December 2019 15:31:17 -0500 (0:00:02.189) 0:04:25.380 ******* 2019-12-13 15:31:17,934 p=11421 u=admin | ok: [jb-ceph4-mon] => msg: The dashboard has been deployed! You can access your dashboard web UI at http://jb-ceph4-mon:8443/ as an 'admin' user with 'p@ssw0rd' password.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力

You can access your dashboard web UI at http://jb-ceph4-mon:8443/ as an 'admin' user with 'p@ssw0rd' password.を書き留めます。

Ansible Playbook は以下を行います。

-

ceph-mgrの Prometheus モジュールを有効にします。 -

ceph-mgrでダッシュボードモジュールを有効にし、TCP ポート 8443 を開きます。 Prometheus の

node_exporterデーモンをストレージクラスターの各ノードにデプロイします。- TCP ポート 9100 を開きます。

-

node_exporterデーモンを起動します。

Ansible インベントリーファイルの

[grafana-server]の下にある Docker/systemd の下に Grafana および Prometheus コンテナーをデプロイします。- 各 Ceph ホストで実行している ceph-mgr ノードおよび node-exporters からデータを収集するように Prometheus を設定します。

- TCP ポート 3000 を開きます。

- Grafana にダッシュボード、テーマ、およびユーザーアカウントを作成します。

- Ceph Dashboard のログインページの URL を表示します。

- 詳細は、Red Hat Ceph Storage インストールガイド の Red Red Hat Ceph Storage クラスター のインストールを参照してください。

- ダッシュボードを削除するには、Red Hat Ceph Storage インストールガイド の Ansible を使用した Ceph ダッシュボードのパージ を参照してください。

2.3. ネットワークポートの要件

Ceph Dashboard のコンポーネントは、アクセス可能である必要のある、特定の TCP ネットワークポートを使用します。デフォルトでは、Red Hat Ceph Storage のインストール時に、ネットワークポートは firewalld で自動的に開きます。

| Port | 下記を使用して、 | 発信元ノード | 送信先ノード |

|---|---|---|---|

| 8443 | ダッシュボードの Web インターフェイス |

AlertManager サービスはアラートを報告するためにダッシュボードへの接続も開始できるため、Ceph ダッシュボード UI および Ansible インベントリーファイルの | Ceph Manager ノード。 |

| 3000 | Grafana |

Grafana ダッシュボード UI およびすべての Ceph Manager ホストと |

Ansible インベントリーファイルの |

| 9090 | 基本的な Prometheus グラフ用のデフォルトの Prometheus サーバー |

Prometheus UI およびすべての Ceph Manager ホスト、および Prometheus を実行しているホスト |

Ansible インベントリーファイルの |

| 9092 | 基本的な Prometheus グラフの Prometheus サーバー |

Prometheus UI およびすべての Ceph Manager ホスト、および Prometheus を実行しているホスト |

Ansible インベントリーファイルの |

| 9093 | Prometheus Alertmanager |

Alertmanager Web UI およびすべての Ceph Manager ホスト、および Prometheus を実行しているホスト |

Ansible インベントリーファイルの |

| 9094 | 複数のインスタンスから作成された可用性の高いクラスターを設定するための Prometheus Alertmanager |

Ansible インベントリーファイルの |

Prometheus Alertmanager 高可用性(ピアデーモン同期)であるため、 |

| 9100 |

Prometheus の |

Node Exporter メトリクス Web UI およびすべての Ceph Manager ノードと |

MON、OSDS、 |

| 9283 | Ceph Manager Prometheus エクスポーターモジュール |

Ceph Exporter メトリクス Web UI および | すべての Ceph Manager ノード。 |

| 9287 | Ceph iSCSI ゲートウェイデータ |

すべての Ceph Manager ホストと | すべての Ceph iSCSI ゲートウェイノード。 |

2.4. ダッシュボードポートの設定

デフォルトでは、Red Hat Ceph Storage ダッシュボードは TCP/IP アドレスと TCP ポートにバインドします。

デフォルトでは、ダッシュボードをホストする ceph-mgr デーモンは、SSL が無効になっている場合、TCP ポート 8443 または 8080 にバインドします。特定のアドレスが設定されていない場合、Web アプリは :: にバインドします。これは、使用可能なすべての IP4 および IP6 アドレスに対応します。

クラスター全体のレベルで設定キー機能を使用して、IP アドレスとポートを変更できます。

前提条件

- Red Hat Ceph Storage クラスター

- Red Hat Ceph Storage ダッシュボードのインストール。

- すべてのノードへの root レベルのアクセス。

手順

ダッシュボードにアクセスするための URL を取得します。

例

ceph mgr services

[root@admin ~]# ceph mgr servicesCopy to Clipboard Copied! Toggle word wrap Toggle overflow ceph-mgrデーモンの現在の IP とポート設定を取得します。例

netstat -ntlp

[root@admin ~]# netstat -ntlpCopy to Clipboard Copied! Toggle word wrap Toggle overflow IP アドレスとポートを設定します。

構文

ceph config set mgr mgr/dashboard/server_addr IP_ADDRESS ceph config set mgr mgr/dashboard/server_port PORT ceph config set mgr mgr/dashboard/ssl_server_port PORT

ceph config set mgr mgr/dashboard/server_addr IP_ADDRESS ceph config set mgr mgr/dashboard/server_port PORT ceph config set mgr mgr/dashboard/ssl_server_port PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

ceph config set mgr mgr/dashboard/server_addr 192.168.0.120 ceph config set mgr mgr/dashboard/server_port 8443 ceph config set mgr mgr/dashboard/ssl_server_port 8443

[root@mon ~]# ceph config set mgr mgr/dashboard/server_addr 192.168.0.120 [root@mon ~]# ceph config set mgr mgr/dashboard/server_port 8443 [root@mon ~]# ceph config set mgr mgr/dashboard/ssl_server_port 8443Copy to Clipboard Copied! Toggle word wrap Toggle overflow オプション:

ceph-mgrはダッシュボードの独自のインスタンスをホストするため、個別に設定できます。特定のマネージャーインスタンスの IP アドレスとポートを変更します。構文

ceph config set mgr mgr/dashboard/NAME/server_addr IP_ADDRESS ceph config set mgr mgr/dashboard/NAME/server_port PORT ceph config set mgr mgr/dashboard/NAME/ssl_server_port PORT

ceph config set mgr mgr/dashboard/NAME/server_addr IP_ADDRESS ceph config set mgr mgr/dashboard/NAME/server_port PORT ceph config set mgr mgr/dashboard/NAME/ssl_server_port PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow Replace: NAME を、ダッシュボードをホストする

ceph-mgrインスタンスの ID に。例

ceph config set mgr mgr/dashboard/mgrs-0/server_addr 192.168.0.120 ceph config set mgr mgr/dashboard/mgrs-0/server_port 8443 ceph config set mgr mgr/dashboard/mgrs-0/ssl_server_port 8443

[root@mon ~]# ceph config set mgr mgr/dashboard/mgrs-0/server_addr 192.168.0.120 [root@mon ~]# ceph config set mgr mgr/dashboard/mgrs-0/server_port 8443 [root@mon ~]# ceph config set mgr mgr/dashboard/mgrs-0/ssl_server_port 8443Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5. ダッシュボードへのアクセス

ダッシュボードにアクセスすると、Red Hat Ceph Storage クラスターを管理および監視できます。

前提条件

- Red Hat Ceph Storage Dashboard の正常なインストール

- NTP はクロックを適切に同期しています。

ノードが適切に同期されない場合に、ダッシュボードノード、クラスターノード、およびブラウザー間で時間ラグが発生する可能性があります。すべてのノードと、ブラウザーを実行するシステムが NTP によって同期されていることを確認します。デフォルトでは、Red Hat Ceph Storage をデプロイすると、Ansible は全ノードに NTP を設定します。確認するには、Red Hat Enterprise Linux 7 の場合は ntpd を使用した NTP 設定 を参照してください。Red Hat Enterprise Linux 8 の場合は Chrony スイートを使用した NTP の設定 を参照してください。別のオペレーティングシステムでブラウザーを実行する場合は、そのオペレーティングシステムのベンダーに NTP 設定情報を確認してください。

Red Hat Ceph Storage で OpenStack Platform (OSP) を使用しているときに OSP Safe Mode を有効にする場合は、以下のいずれかの方法を使用します。Ansible で Ansible Playbook の group_vars/all.yml を編集し、dashboard_admin_user_ro: true を設定してから、ベアメタルまたはコンテナーデプロイメントのそれぞれ site.yml または site-container.yml に対して ansible-playbook を再実行します。ceph コマンドを使用して OSP Safe Mode を有効にするには、ceph dashboard ac-user-set-roles admin read-only を実行します。Ansible Playbook の ceph-ansible を実行しても変更が維持されるようにするには、group_vars/all.yml を編集して Dashboard_admin_user_ro: true を設定します。

手順

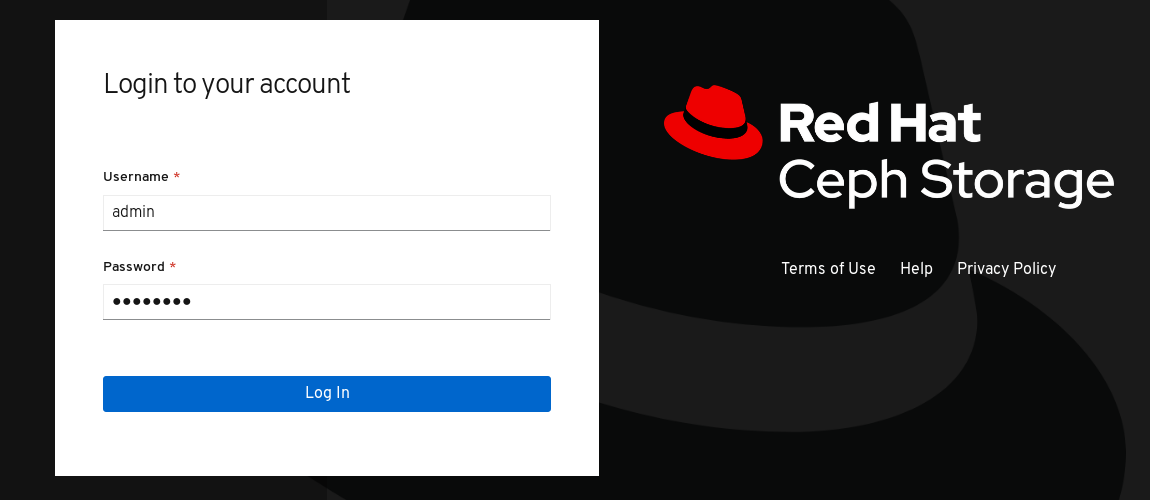

Web ブラウザーで、以下の URL を入力します。

http://HOST_NAME:PORT

http://HOST_NAME:PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下を置き換えます。

- HOST_NAME は、ダッシュボードノードのホスト名に置き換えます。

PORT は、ポート

8443に置き換えます。以下は例になります。

http://dashboard:8443

http://dashboard:8443Copy to Clipboard Copied! Toggle word wrap Toggle overflow

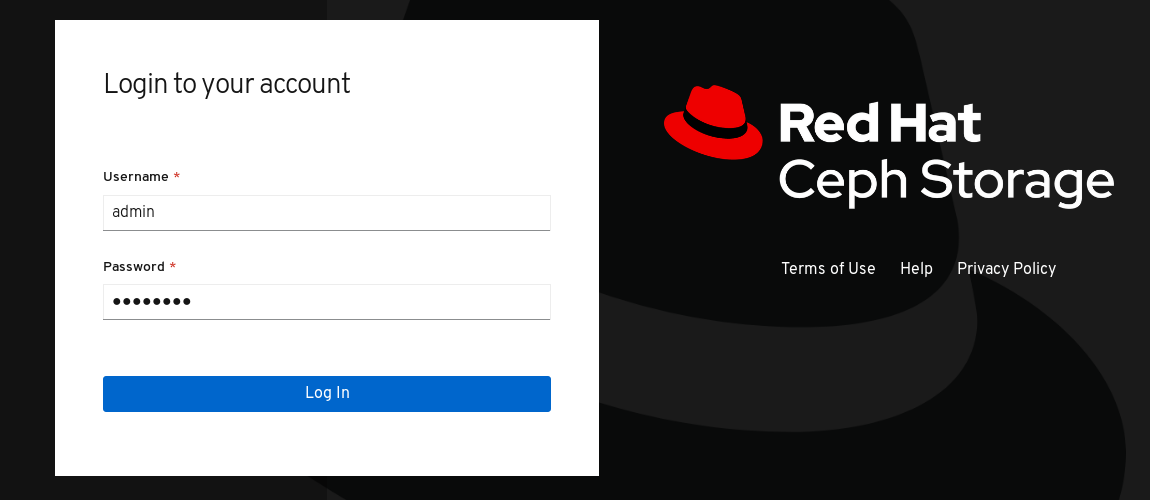

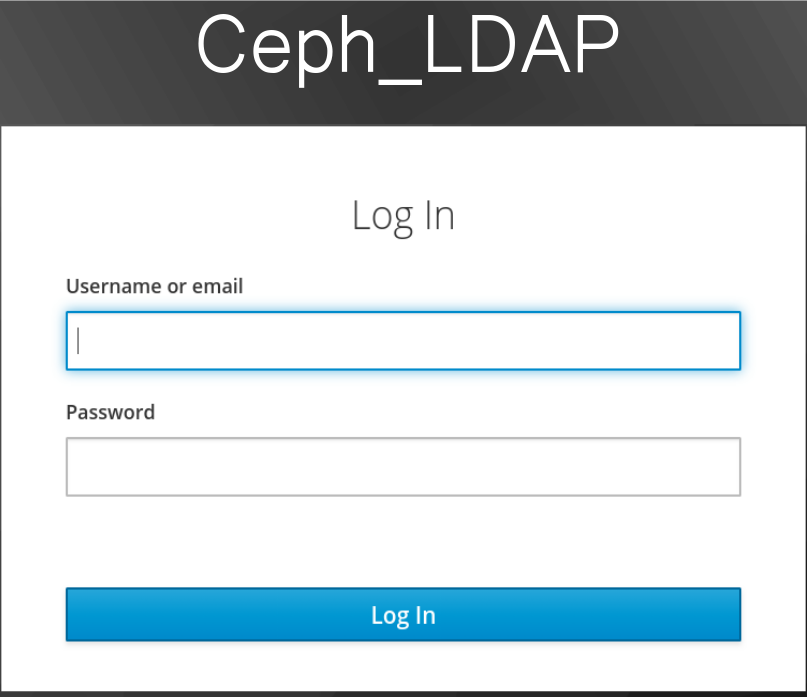

インストール時にパスワードを変更しなかった場合は、ログインページでユーザー名

adminとデフォルトパスワードp@ssw0rdを入力します。図2.1 Ceph Dashboard ログインページ

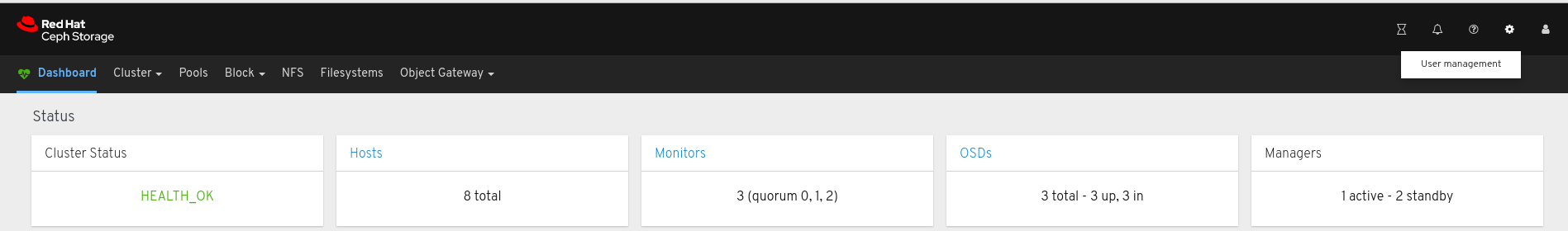

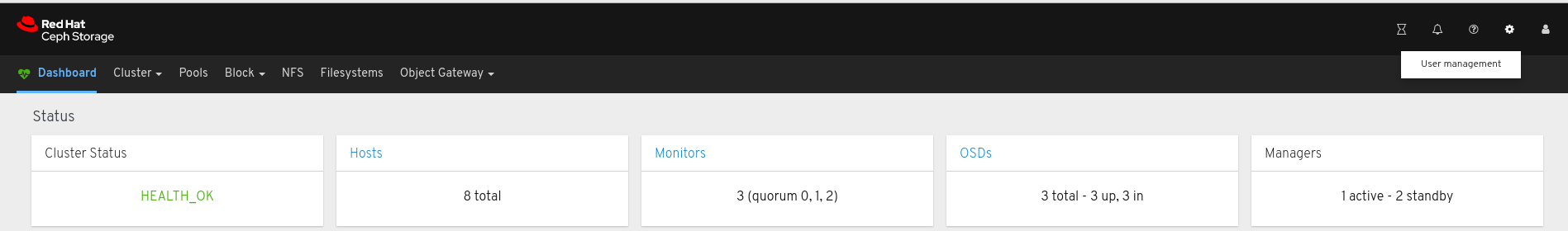

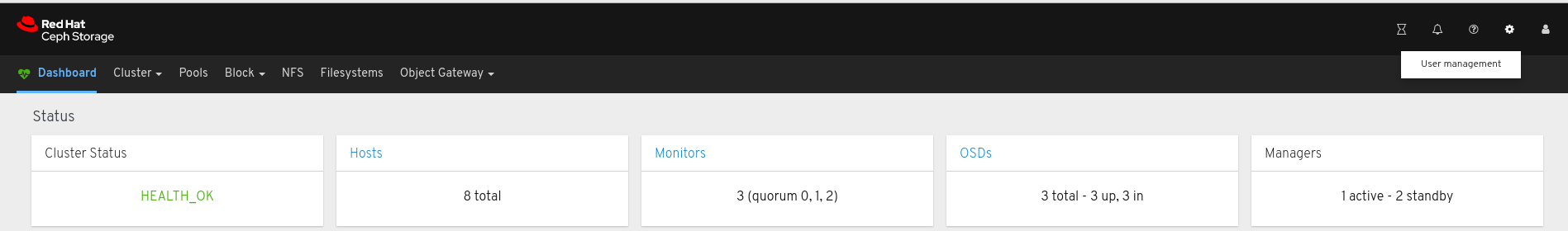

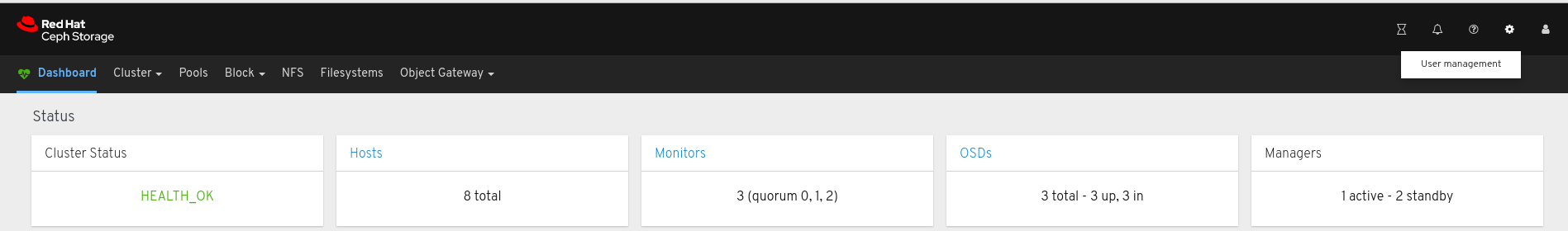

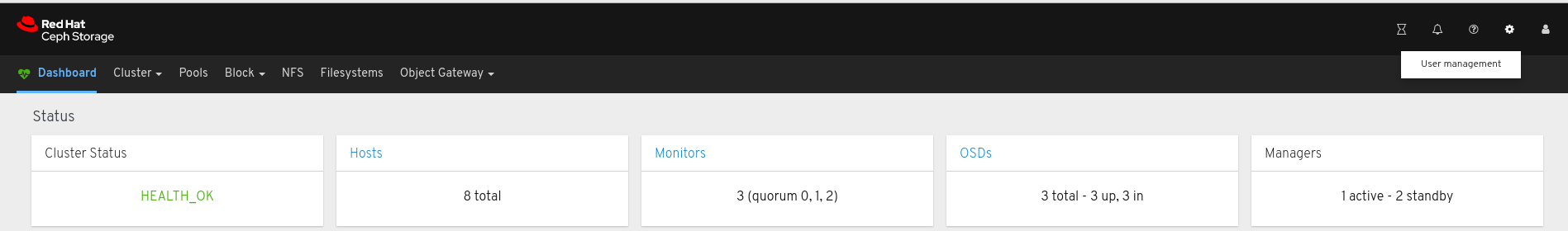

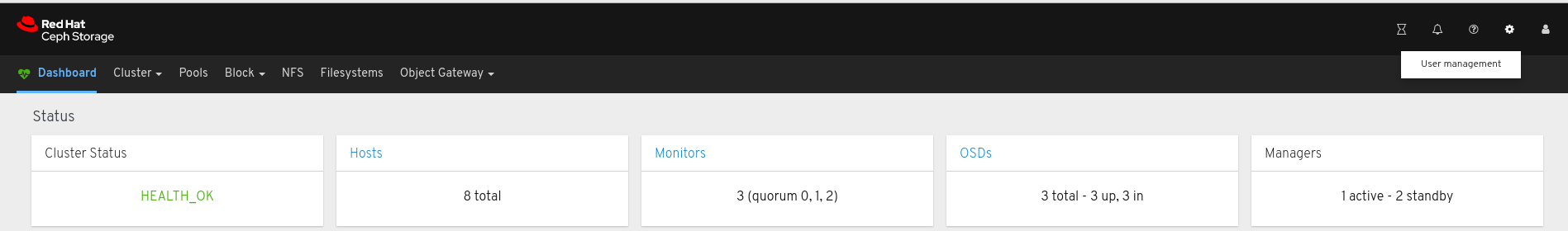

ログイン後、ダッシュボードのデフォルトランディングページが表示され、Red Hat Ceph Storage クラスターのステータス、パフォーマンス、および容量のメトリックの概要が提供されています。

図2.2 Ceph Dashboard のデフォルトのランディングページ

関連情報

- 詳細は、ダッシュボードガイド の ダッシュボードを使用したダッシュボードパスワードの変更 を参照してください。

- 詳細は、ダッシュボードガイド の Ansible を使用したダッシュボードパスワードの変更 を参照してください。

2.6. Ansible を使用したダッシュボードパスワードの変更

デフォルトでは、ダッシュボードにアクセスするためのパスワードは p@ssw0rd に設定されます。

セキュリティー上の理由から、インストール後にパスワードを変更します。

Ansible を使用してダッシュボードのパスワードを変更できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Ansible 管理ノードへのアクセス

手順

-

Ansible Playbook ファイル

/usr/share/ceph-ansible/group_vars/all.ymlを開いて編集します。 この行でコメント解除してパスワードを更新します。

#dashboard_admin_password: p@ssw0rd

#dashboard_admin_password: p@ssw0rdCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のように変更します。

dashboard_admin_password: NEW_PASSWORD

dashboard_admin_password: NEW_PASSWORDCopy to Clipboard Copied! Toggle word wrap Toggle overflow NEW_PASSWORD を、希望するパスワードに置き換えます。

Ceph クラスターをデプロイまたは更新する Ansible Playbook ファイルを再実行します。

ベアメタルのインストールには、Playbook の

site.ymlを使用します。ansible-playbook -v site.yml

[admin@admin ceph-ansible]$ ansible-playbook -v site.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンテナーのインストールには、Playbook の

site-docker.ymlを使用します。ansible-playbook -v site-docker.yml

[admin@admin ceph-ansible]$ ansible-playbook -v site-docker.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- 新しいパスワードを使用してログインします。

関連情報

- 詳細は、ダッシュボードガイド の ダッシュボードを使用したダッシュボードパスワードの変更 を参照してください。

2.7. ダッシュボードを使用したダッシュボードパスワードの変更

デフォルトでは、ダッシュボードにアクセスするためのパスワードは p@ssw0rd に設定されます。

セキュリティー上の理由から、インストール後にパスワードを変更します。

ダッシュボードを使用してパスワードを変更するには、Ansible でダッシュボードのパスワード設定を変更して、Red Hat Ceph Storage クラスターの再設定に Ansible が使用されている場合は、パスワードがデフォルトのパスワードに戻らないようにします。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

手順

group_vars/all.ymlファイルでパスワードを更新し、Ansible を使用して Ceph クラスターを再設定する際にパスワードがp@ssw0rdにリセットされないようにします。-

Ansible Playbook ファイル

/usr/share/ceph-ansible/group_vars/all.ymlを開いて編集します。 この行でコメント解除してパスワードを更新します。

#dashboard_admin_password: p@ssw0rd

#dashboard_admin_password: p@ssw0rdCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のように変更します。

dashboard_admin_password: NEW_PASSWORD

dashboard_admin_password: NEW_PASSWORDCopy to Clipboard Copied! Toggle word wrap Toggle overflow NEW_PASSWORD を、希望するパスワードに置き換えます。

-

Ansible Playbook ファイル

ダッシュボードの Web ユーザーインターフェイスでパスワードを変更します。

ダッシュボードにログインします。

http://HOST_NAME:8443

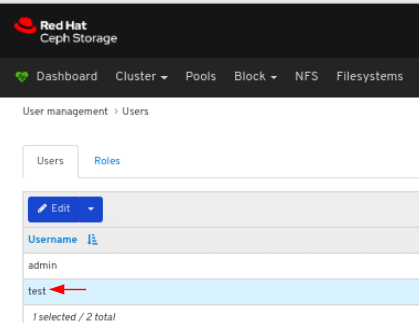

http://HOST_NAME:8443Copy to Clipboard Copied! Toggle word wrap Toggle overflow ツールバーの右上のダッシュボード設定アイコンをクリックして、User management をクリックします。

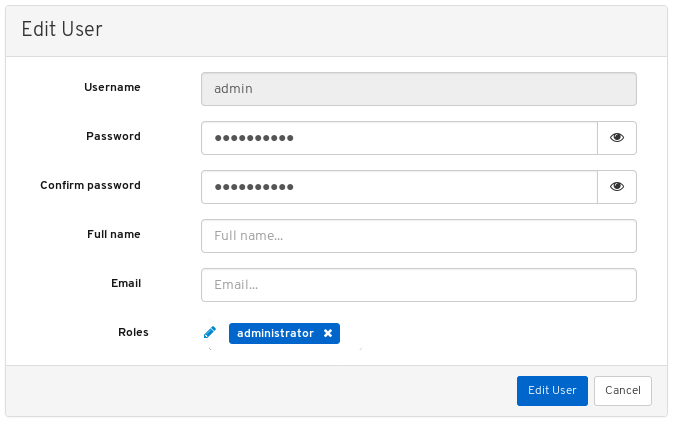

Username テーブルで

adminユーザーを見つけ、admin をクリックします。

- テーブルタイトルの Username にある Edit ボタンをクリックします。

新しいパスワードを入力し、再入力して Edit User をクリックします。

ログアウトし、ログイン画面が表示されます。パスワードの変更を確認する通知が表示されます。

- 新しいパスワードを使用して再度ログインします。

関連情報

- 詳細は、ダッシュボードガイド の Ansible を使用したダッシュボードパスワードの変更 を参照してください。

2.8. Ansible を使用した Grafana パスワードの変更

デフォルトでは、ダッシュボードで使用される Grafana のパスワードは admin に設定されます。パスワードを変更するには、以下の手順に従います。

セキュリティー上の理由から、パスワードをデフォルトから変更してください。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クラスター内のすべてのノードへの root アクセス。

手順

オプション: Grafana コンテナーが実行されているノードがわからない場合は、通常は

/etc/ansible/hostsにある Ansible ホストファイルのgrafana-server の下にリストされているノードを見つけます。例

[grafana-server] grafana

[grafana-server] grafanaCopy to Clipboard Copied! Toggle word wrap Toggle overflow Grafana コンテナーが実行されているノードで、パスワードを変更します。

構文

podman exec CONTAINER_ID grafana-cli admin reset-admin-password --homepath "/usr/share/grafana" NEW_PASSWORD

podman exec CONTAINER_ID grafana-cli admin reset-admin-password --homepath "/usr/share/grafana" NEW_PASSWORDCopy to Clipboard Copied! Toggle word wrap Toggle overflow CONTAINER_ID を Grafana コンテナーの ID に変更します。NEW_PASSWORD を必要な Grafana パスワードに変更します。

例

podman exec 3f28b0309aee grafana-cli admin reset-admin-password --homepath "/usr/share/grafana" NewSecurePassword t=2020-10-29T17:45:58+0000 lvl=info msg="Connecting to DB" logger=sqlstore dbtype=sqlite3 t=2020-10-29T17:45:58+0000 lvl=info msg="Starting DB migration" logger=migrator Admin password changed successfully ✔

[root@grafana ~]# podman exec 3f28b0309aee grafana-cli admin reset-admin-password --homepath "/usr/share/grafana" NewSecurePassword t=2020-10-29T17:45:58+0000 lvl=info msg="Connecting to DB" logger=sqlstore dbtype=sqlite3 t=2020-10-29T17:45:58+0000 lvl=info msg="Starting DB migration" logger=migrator Admin password changed successfully ✔Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ansible 管理ノードで、

ansible-vaultを使用して Grafana パスワードを暗号化し、暗号化されたパスワードをgroup_vars/all.ymlに追加します。/usr/share/ceph-ansible/ディレクトリーに移動します。cd /usr/share/ceph-ansible/

[admin@admin ~]$ cd /usr/share/ceph-ansible/Copy to Clipboard Copied! Toggle word wrap Toggle overflow ansible-vaultを実行して、新しい vault パスワードを作成します。例

ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password:

[admin@admin ceph-ansible]$ ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password:Copy to Clipboard Copied! Toggle word wrap Toggle overflow パスワードを再入力して確定します。

例

ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password: Confirm New Vault password:

[admin@admin ceph-ansible]$ ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password: Confirm New Vault password:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Grafana パスワードを入力し、Enter を押してから CTRL+D を入力してエントリーを完了します。

構文

ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password: Confirm New Vault password: Reading plaintext input from stdin. (ctrl-d to end input) NEW_PASSWORD

ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password: Confirm New Vault password: Reading plaintext input from stdin. (ctrl-d to end input) NEW_PASSWORDCopy to Clipboard Copied! Toggle word wrap Toggle overflow NEW_PASSWORD は、以前に設定した Grafana パスワードに置き換えます。

例

ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password: Confirm New Vault password: Reading plaintext input from stdin. (ctrl-d to end input) NewSecurePassword

[admin@admin ceph-ansible]$ ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password: Confirm New Vault password: Reading plaintext input from stdin. (ctrl-d to end input) NewSecurePasswordCopy to Clipboard Copied! Toggle word wrap Toggle overflow grafana_admin_password_vault: !vault |で開始し、数字の行 2-3 行で終了する出力をメモし、次の手順で使用します。例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow group_vars/all.ymlを編集し、上記からの出力をファイルに貼り付けます。例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下を使用して、暗号化されたパスワードの下に行を追加します。

例

grafana_admin_password: "{{ grafana_admin_password_vault }}"grafana_admin_password: "{{ grafana_admin_password_vault }}"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記上記のように 2 つの変数を使用する必要があります。これは、Ansible のバグ が原因で、vault 値を直接 Ansible 変数に割り当てる時に、文字列のタイプが破損するためです。

- ファイルを保存してから閉じます。

ansible-playbookを再実行します。コンテナーベースのデプロイメントの場合:

例

ansible-playbook --ask-vault-pass -v site-container.yml -i hosts

[admin@node1 ceph-ansible]$ ansible-playbook --ask-vault-pass -v site-container.yml -i hostsCopy to Clipboard Copied! Toggle word wrap Toggle overflow -i hostsは、デフォルトの Ansible hosts ファイルの場所 (/etc/ansible/hosts) を使用していない場合にのみ必要であることに注意してください。ベアメタルの場合、RPM ベースのデプロイメントの場合:

例

ansible-playbook --ask-vault-pass -v site.yml -i hosts

[admin@node1 ceph-ansible]$ ansible-playbook --ask-vault-pass -v site.yml -i hostsCopy to Clipboard Copied! Toggle word wrap Toggle overflow -i hostsは、デフォルトの Ansible hosts ファイルの場所 (/etc/ansible/hosts) を使用していない場合にのみ必要であることに注意してください。

2.9. ダッシュボードの Red Hat Single Sign-On を使用したユーザーの同期

管理者は、Red Hat Single Sign-on (SSO) と Lightweight Directory Access Protocol (LDAP) 統合を使用して、Red Hat Ceph Storage ダッシュボードのユーザーにアクセスできます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- ダッシュボードへの管理者レベルのアクセス権。

- ユーザーをダッシュボードに追加しておく。

- すべてのノードでの root レベルのアクセス。

- Red hat Single Sign-On を ZIP ファイルからインストールしておく。詳細は、Zip ファイルからの Red Hat Single Sign-On のインストール を参照してください。

手順

- Red Hat Ceph ストレージがインストールされているシステムに Red Hat Single Sign-On 7.4.0 サーバー をダウンロードします。

フォルダーを展開します。

unzip rhsso-7.4.0.zip

[root@cephuser]# unzip rhsso-7.4.0.zipCopy to Clipboard Copied! Toggle word wrap Toggle overflow standalone/configurationディレクトリーに移動し、standalone.xmlを開いて編集します。cd standalone/configuration vi standalone.xml

[root@cephuser]# cd standalone/configuration [root@cephuser configuration]# vi standalone.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

localhostの 3 つのインスタンスと127.0.0.1の 2 つのインスタンスは、Red Hat Single Sign-On がインストールされているマシンの IP アドレスに置き換えます。 オプション: Red Hat Enterprise Linux 8 の場合には、認証局 (CA) の問題が発生する可能性があります。CA からカスタム証明書をインポートして、正確な Java バージョンを使用するキーストアに移動します。

例

keytool -import -noprompt -trustcacerts -alias ca -file ../ca.cer -keystore /etc/java/java-1.8.0-openjdk/java-1.8.0-openjdk-1.8.0.272.b10-3.el8_3.x86_64/lib/security/cacert

[root@cephuser]# keytool -import -noprompt -trustcacerts -alias ca -file ../ca.cer -keystore /etc/java/java-1.8.0-openjdk/java-1.8.0-openjdk-1.8.0.272.b10-3.el8_3.x86_64/lib/security/cacertCopy to Clipboard Copied! Toggle word wrap Toggle overflow rh-sso-7.4フォルダーのbinディレクトリーからサーバーを起動するには、standaloneブートスクリプトを実行します。./standalone.sh

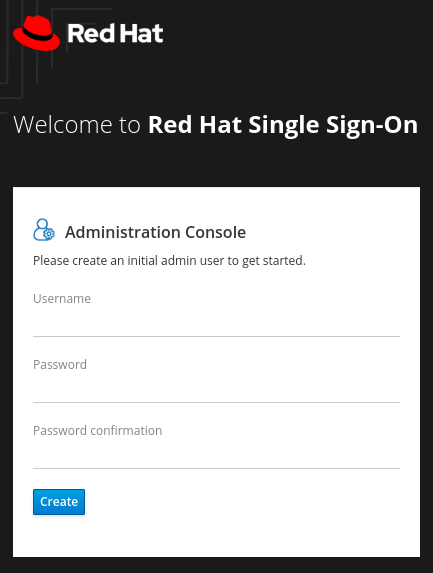

[root@cephuser bin]# ./standalone.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow ユーザー名とパスワードを指定して、https:_IP_ADDRESS_:8080/auth で管理アカウントを作成します。

注記

注記admin アカウントは、コンソールに初めてログインするときにのみ作成する必要があります。

作成された認証情報を使用して管理コンソールにログインします。

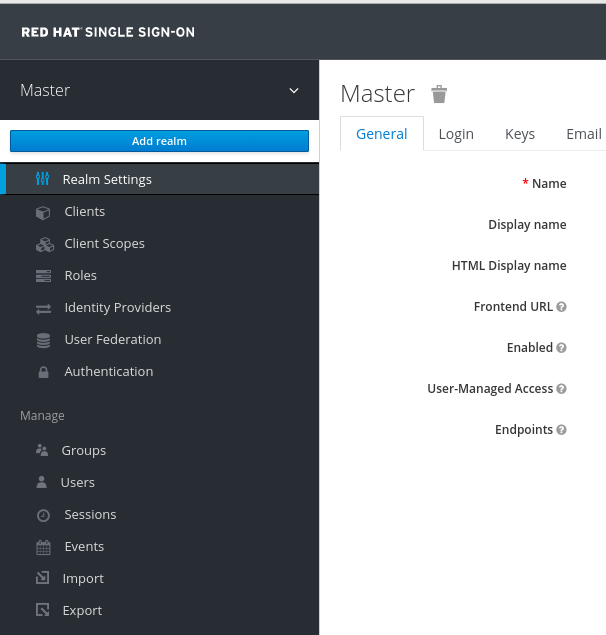

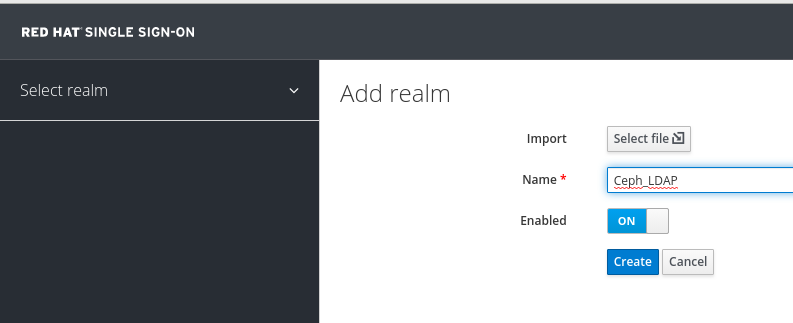

レルムを作成するには、Master ドロップダウンをクリックします。このレルムでは、管理者はユーザーおよびアプリケーションにアクセスできます。

Add Realm ウィンドウで、レルムの名前を入力し、パラメーター Enabled を ON に設定し、Create をクリックします。

注記

注記レルム名は大文字と小文字が区別されます。

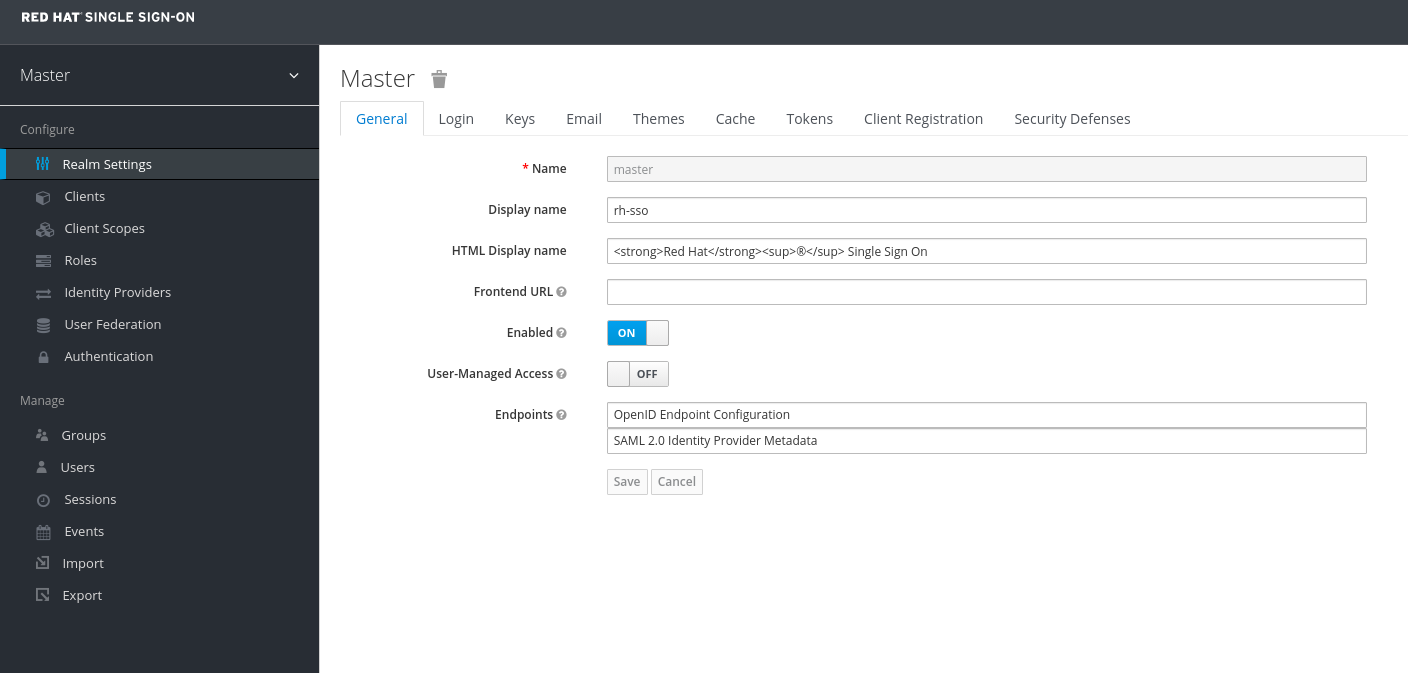

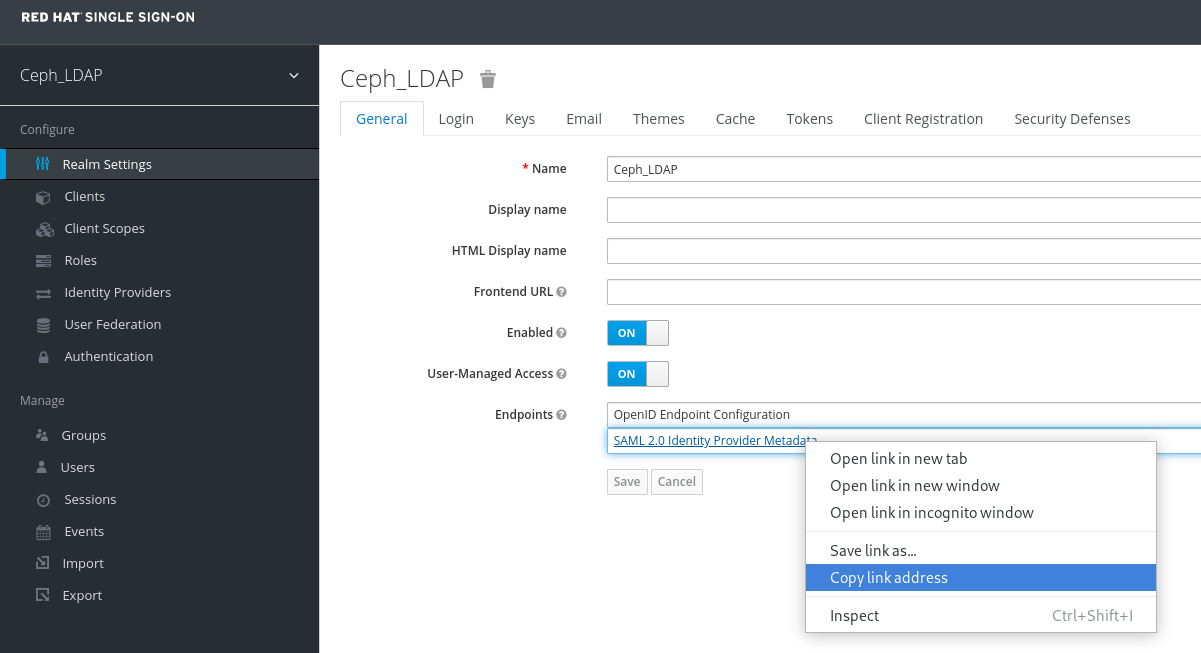

Realm Settings タブで、次のパラメーターを設定し、Save をクリックします。

- Enabled - ON

- User-Managed Access - ON

SAML 2.0 アイデンティティープロバイダーメタデータのリンクアドレスをコピーします。

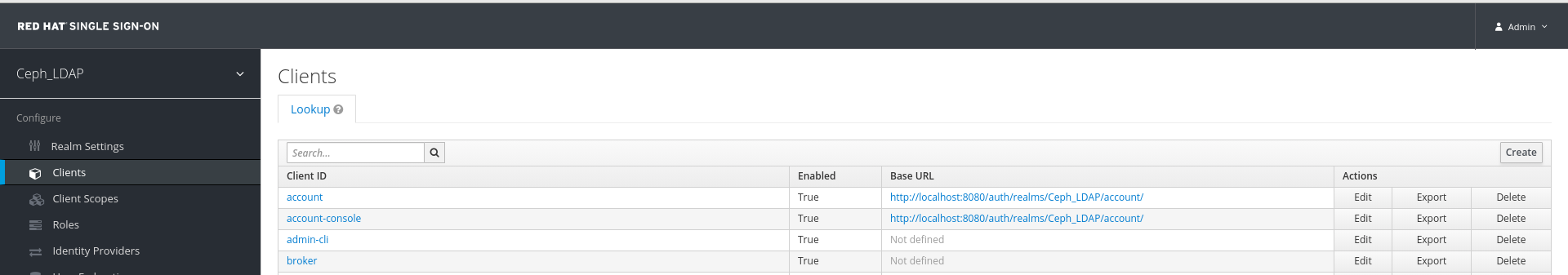

Clients タブで、Create をクリックします。

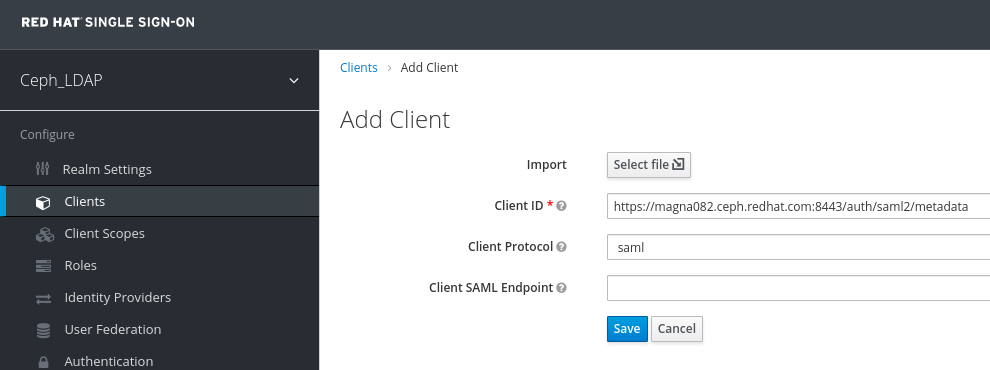

Add Client ウィンドウで、次のパラメーターを設定し、Save をクリックします。

クライアント ID - BASE_URL:8443/auth/saml2/metadata

例

https://magna082.ceph.redhat.com:8443/auth/saml2/metadata

クライアントプロトコル - saml

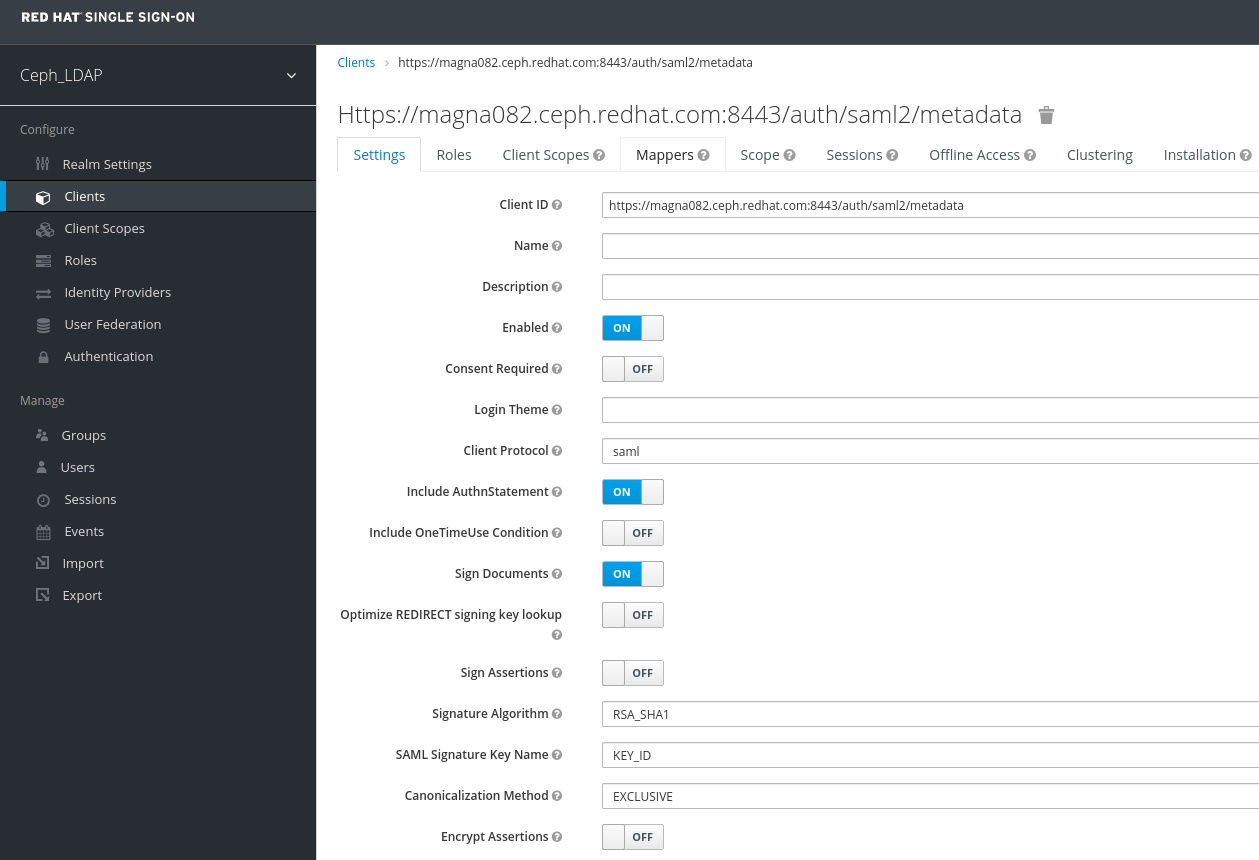

Clients ウィンドウの Settings タブで、次のパラメーターを設定し、Save をクリックします。

クライアント ID - BASE_URL:8443/auth/saml2/metadata

例

https://magna082.ceph.redhat.com:8443/auth/saml2/metadata

- Enabled - ON

- クライアントプロトコル - saml

- Include AuthnStatement - ON

- Sign Documents - ON

- Signature Algorithm - RSA_SHA1

- SAML Signature Key Name - KEY_ID

Valid Redirect URLs - BASE_URL:8443/*

例

https://magna082.ceph.redhat.com:8443/*

Base URL - BASE_URL:8443

例

https://magna082.ceph.redhat.com:8443/

Master SAML Processing URL - http://localhost:8080/auth/realms/REALM_NAME/protocol/saml/descriptor

例

http://localhost:8080/auth/realms/Ceph_LDAP/protocol/saml/descriptor

注記Realm Settings タブから SAML 2.0 アイデンティティープロバイダーメタデータのリンクを貼り付けます。

Fine Grain SAML Endpoint Configuration で、パラメーターを設定します。

assertion Consumer Service POST Binding URL - BASE_URL:8443/#/dashboard

例

https://magna082.ceph.redhat.com:8443/#/dashboard

Assertion Consumer Service Redirect Binding URL - BASE_URL:8443/#/dashboard

例

https://magna082.ceph.redhat.com:8443/#/dashboard

Logout Service Redirect Binding URL - BASE_URL:8443/

例

https://magna082.ceph.redhat.com:8443/

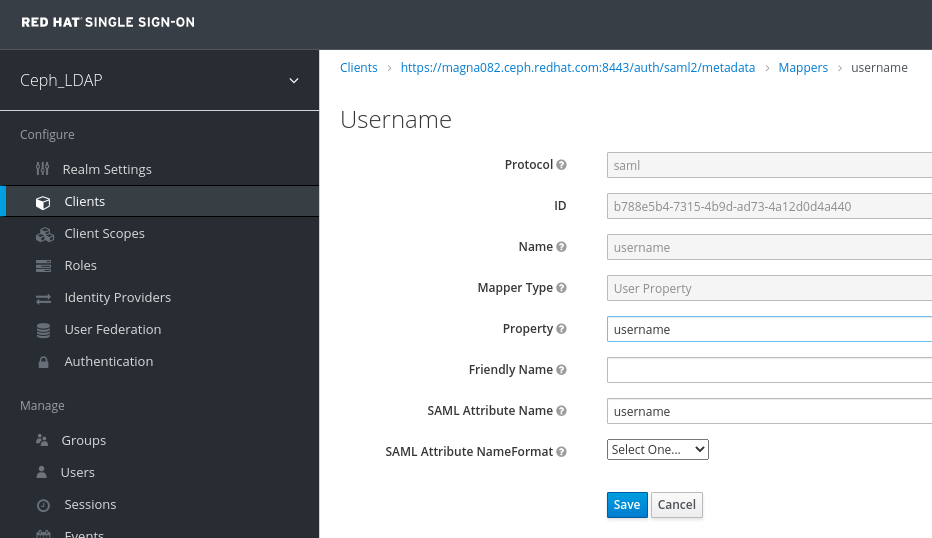

Clients ウィンドウの Mappers タブで、次のパラメーターを設定し、Save をクリックします。

- protocol - saml

- name: username

- Mapper Property - User Property

- property - username

SAML Attribute name - username

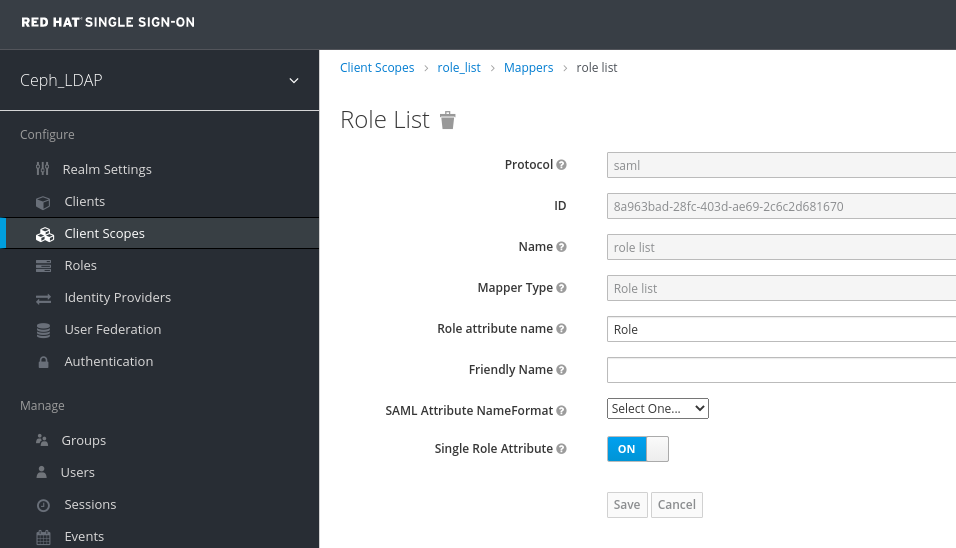

Clients Scope タブで、role_list を選択します。

Mappers タブで、role list を選択し、Single Role Attribute をオンに設定します。

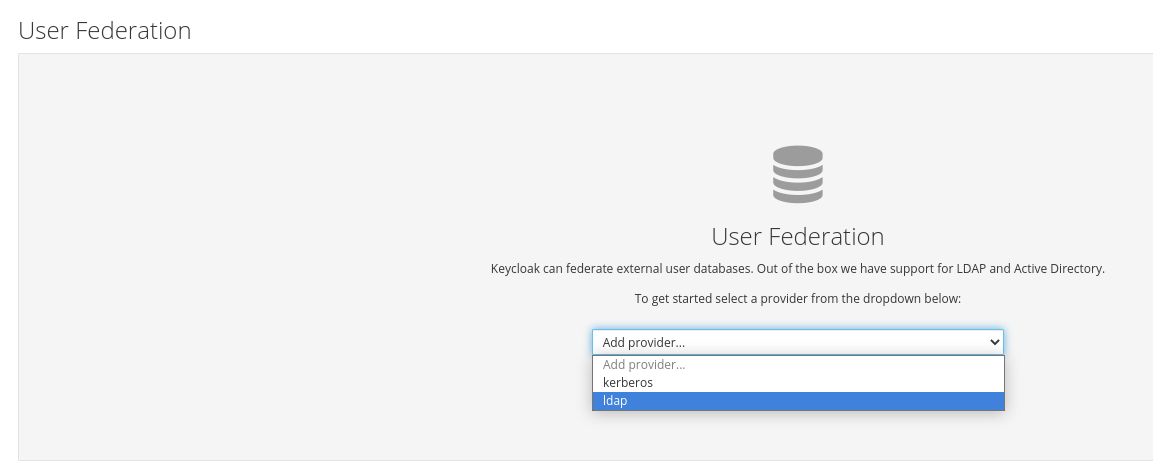

User_Federation タブを選択します。

User Federation ウィンドウで、ドロップダウンメニューから LDAP を選択します。

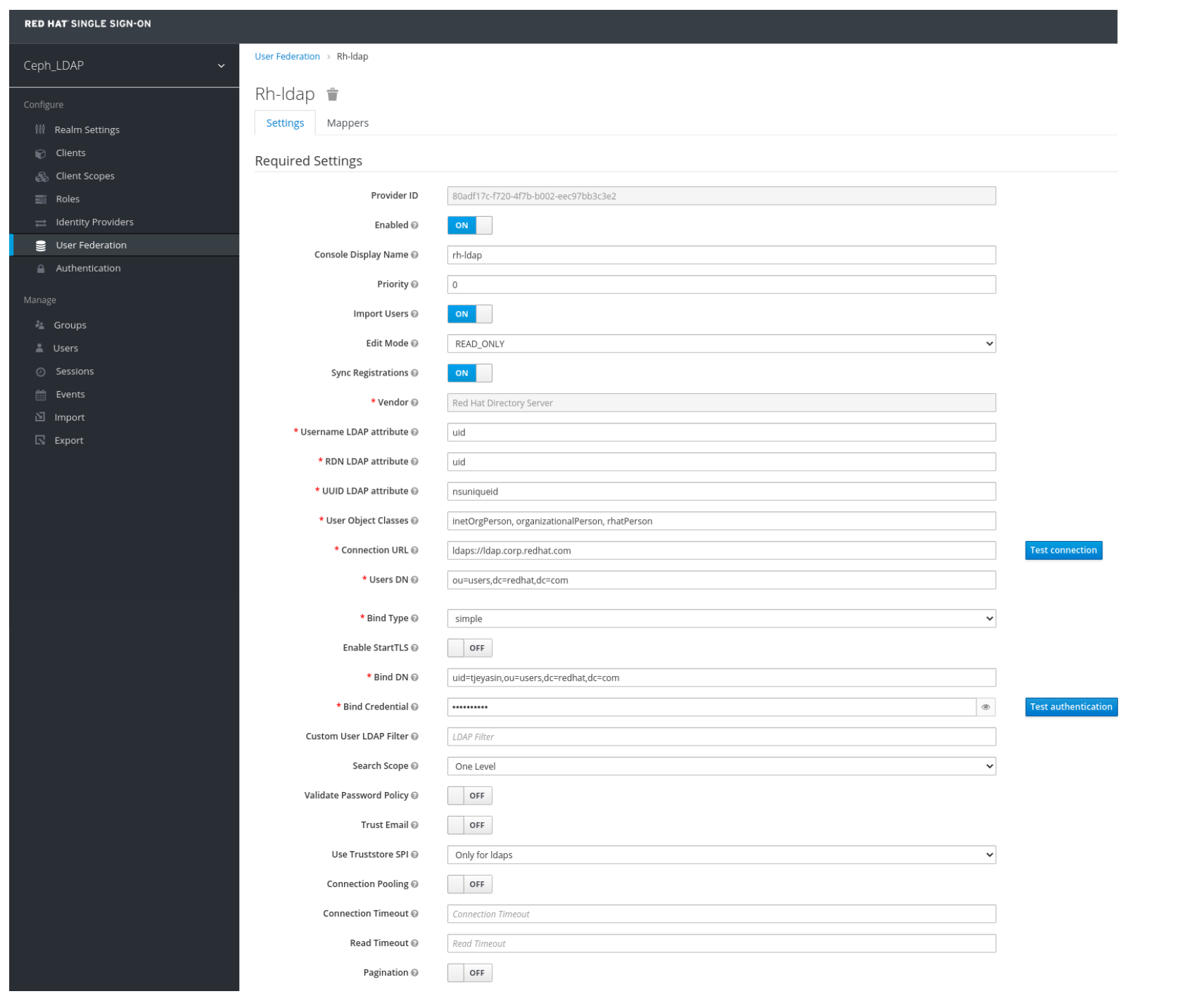

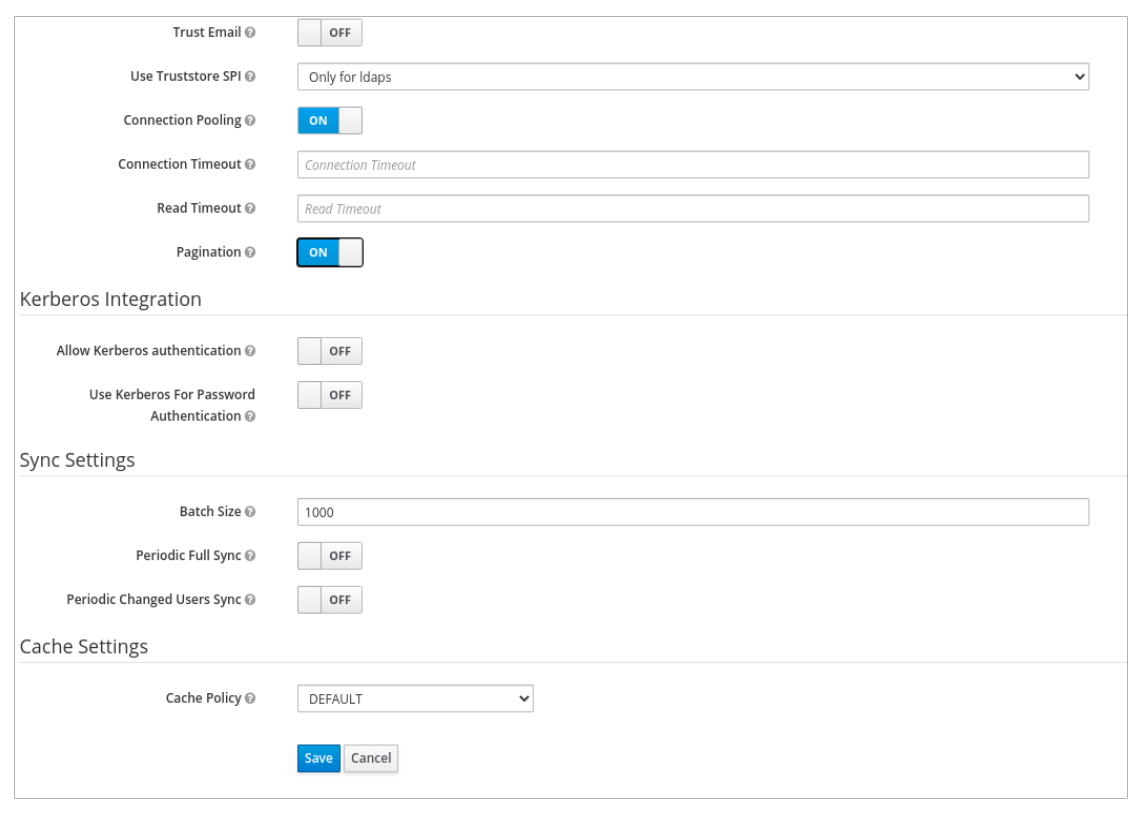

User_Federation ウィンドウの Settings タブで、次のパラメーターを設定し、Save をクリックします。

- Console Display Name - rh-ldap

- Import Users - ON

- Edit_Mode - READ_ONLY

- Username LDAP attribute - username

- RDN LDAP attribute - username

- UUID LDAP attribute - nsuniqueid

- User Object Classes - inetOrgPerson, organizationalPerson, rhatPerson

Connection URL - ldap:://myldap.example.com

例

ldap://ldap.corp.redhat.com

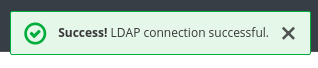

Test Connection をクリックします。

LDAP 接続が成功したという通知が表示されます。

Users DN - ou=users, dc=example, dc=com

例

ou=users,dc=redhat,dc=com

Bind Type - simple

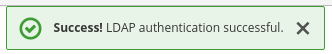

Test authentication をクリックします。

LDAP 認証が成功したという通知が表示されます。

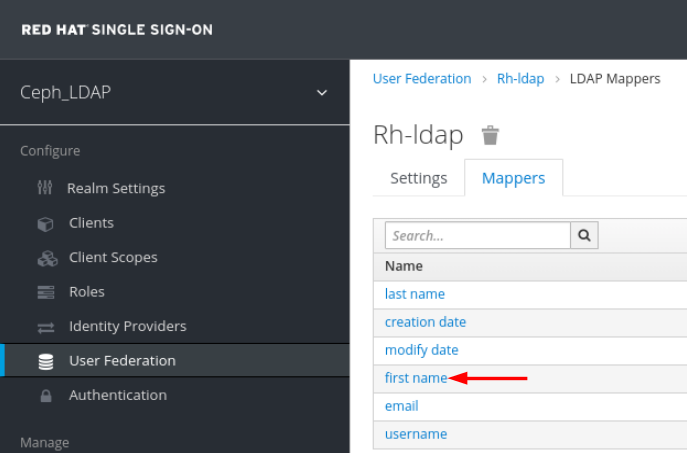

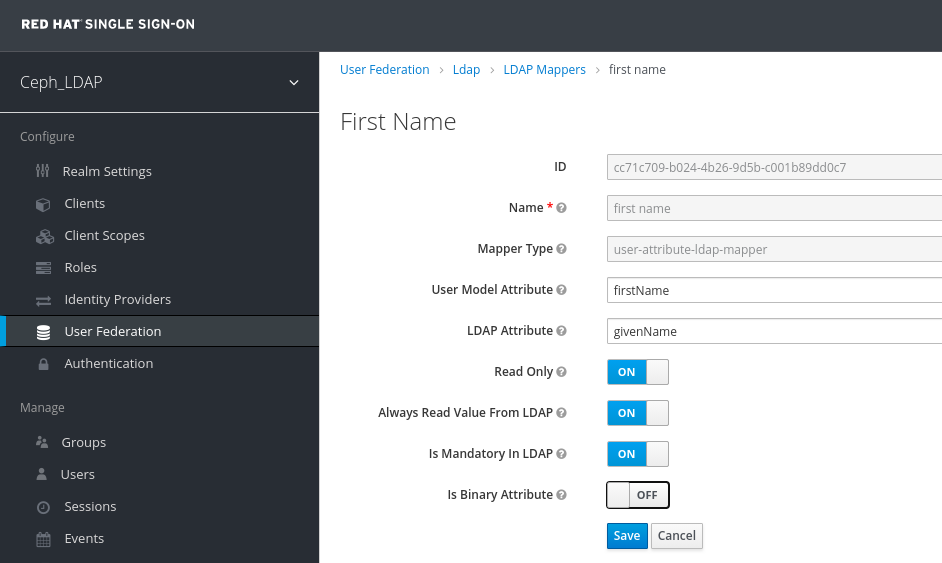

Mappers タブで、first name の行を選択して、以下のパラメーターを編集し、Save をクリックします。

LDAP 属性 - GivenName

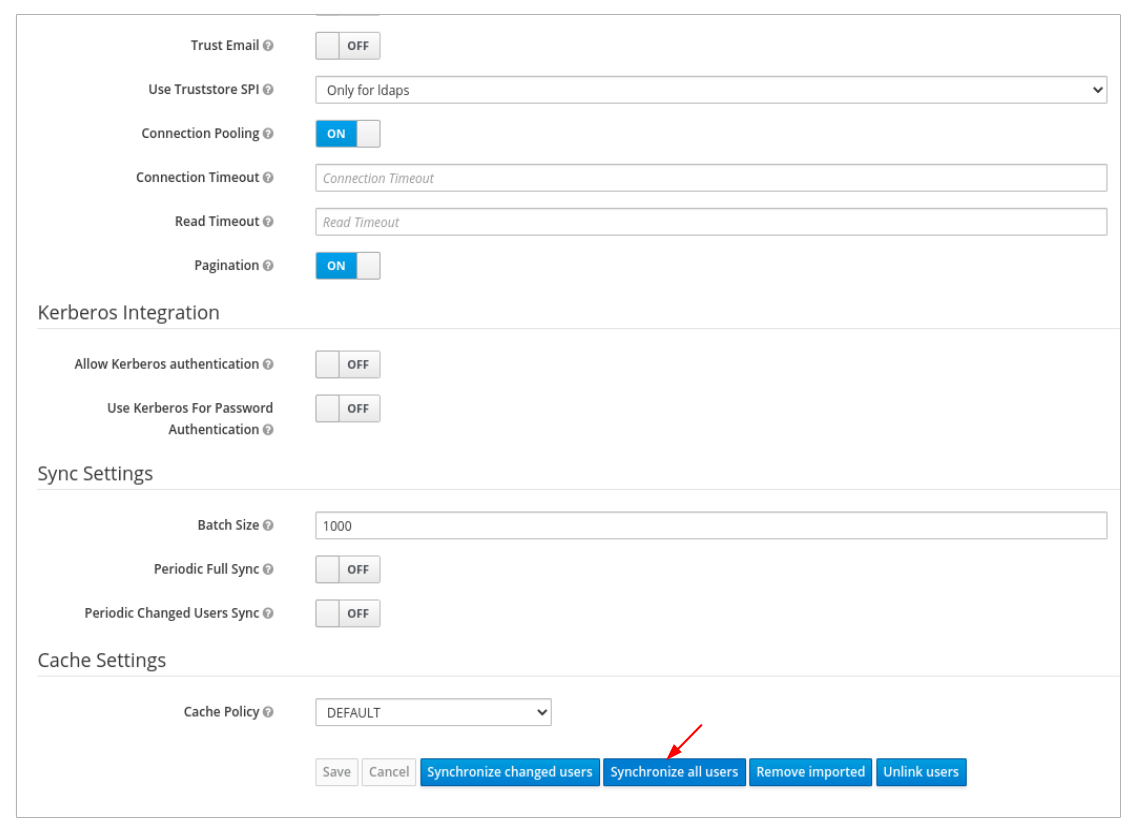

User_Federation タブの Settings タブで、Synchronize all users をクリックします。

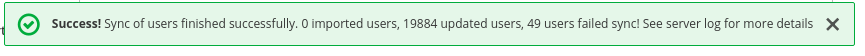

ユーザーの同期が正常に更新されたという通知が表示されます。

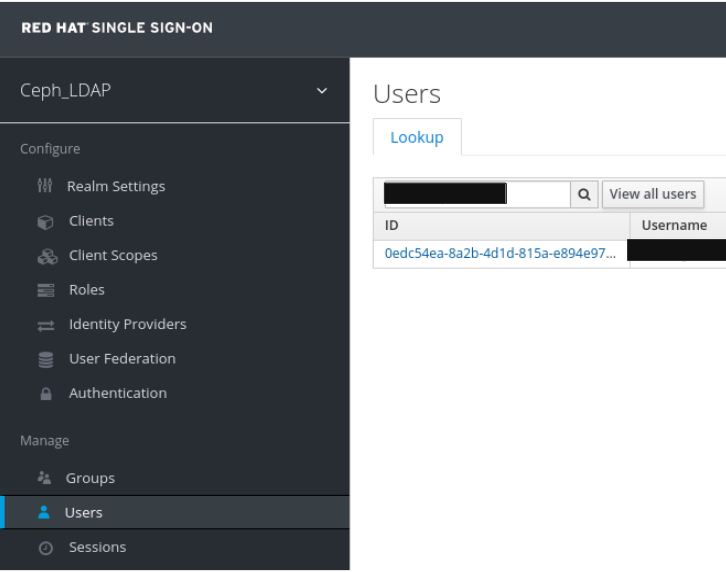

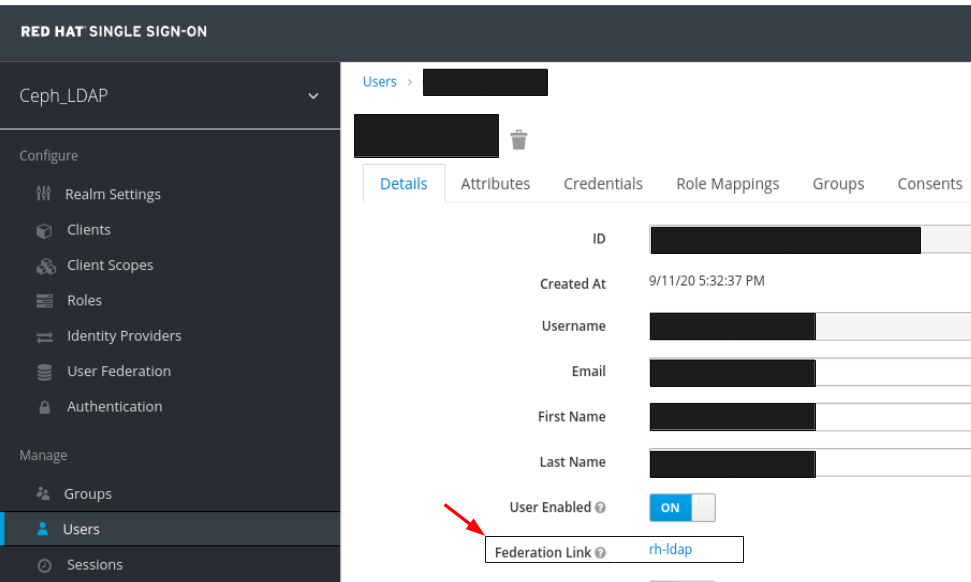

Users タブで、ダッシュボードに追加されたユーザーを検索し、検索アイコンをクリックします。

ユーザーを表示するには、その行をクリックします。フェデレーションリンクは、User Federation で指定した名前で表示されます。

重要

重要ユーザーは手動で追加しないでください。手動で追加した場合は、Delete をクリックしてユーザーを削除します。

レルムとダッシュボードに追加されたユーザーは、メールアドレスとパスワードを使用して Ceph Dashboard にアクセスできます。

例

https://magna082.ceph.redhat.com:8443

関連情報

- ダッシュボードにユーザーを追加する方法については、Red Hat Ceph Storage ダッシュボードガイド の ダッシュボードでのユーザーの作成 セクションを参照してください。

- ダッシュボードでユーザーのロールを追加する方法は、Red Hat Ceph Storage ダッシュボードガイドの ダッシュボードでのロールの作成 セクションを参照してください。

2.10. Ceph Dashboard のシングルサインオンの有効化

Ceph Dashboard は、Security Assertion Markup Language (SAML) プロトコルを使用したユーザーの外部認証をサポートします。Ceph ダッシュボードにシングルサインオン (SSO) を使用する前に、ダッシュボードのユーザーアカウントを作成して必要なロールを割り当てます。Ceph Dashboard はユーザーの承認を実行し、認証プロセスは既存のアイデンティティープロバイダー (IdP) によって実行されます。Red Hat は、Keycloak を使用してダッシュボードの SSO 機能をテストします。

前提条件

- 稼働中の Red Hat Ceph Storage クラスター

- Ceph Dashboard ソフトウェアのインストール

- Dashboard を起動します。

- Ceph Manager ノードへのルートレベルのアクセス。

以下のライブラリーパッケージを Ceph Manager ノードにインストールします。

-

python3-saml -

python3-defusedxml -

python3-isodate -

python3-xmlsec

-

手順

Ceph Dashboard で SSO を設定するには、以下のコマンドを実行します。

ベアメタル デプロイメント:

構文

ceph dashboard sso setup saml2 CEPH_DASHBOARD_BASE_URL IDP_METADATA IDP_USERNAME_ATTRIBUTE IDP_ENTITY_ID SP_X_509_CERT SP_PRIVATE_KEY

ceph dashboard sso setup saml2 CEPH_DASHBOARD_BASE_URL IDP_METADATA IDP_USERNAME_ATTRIBUTE IDP_ENTITY_ID SP_X_509_CERT SP_PRIVATE_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

ceph dashboard sso setup saml2 http://dashboard_hostname.ceph.redhat.com:8443 idp-metadata.xml username http://10.70.59.125:8080/auth/realms/realm_name /home/certificate.txt /home/private-key.txt

[root@mon ~]# ceph dashboard sso setup saml2 http://dashboard_hostname.ceph.redhat.com:8443 idp-metadata.xml username http://10.70.59.125:8080/auth/realms/realm_name /home/certificate.txt /home/private-key.txtCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンテナー デプロイメント:

構文

podman exec CEPH_MGR_NODE ceph dashboard sso setup saml2 CEPH_DASHBOARD_BASE_URL IDP_METADATA IDP_USERNAME_ATTRIBUTE IDP_ENTITY_ID SP_X_509_CERT SP_PRIVATE_KEY

podman exec CEPH_MGR_NODE ceph dashboard sso setup saml2 CEPH_DASHBOARD_BASE_URL IDP_METADATA IDP_USERNAME_ATTRIBUTE IDP_ENTITY_ID SP_X_509_CERT SP_PRIVATE_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

podman exec ceph-mgr-hostname ceph dashboard sso setup saml2 http://dashboard_hostname.ceph.redhat.com:8443 idp-metadata.xml username http://10.70.59.125:8080/auth/realms/realm_name /home/certificate.txt /home/private-key.txt

[root@mon ~]# podman exec ceph-mgr-hostname ceph dashboard sso setup saml2 http://dashboard_hostname.ceph.redhat.com:8443 idp-metadata.xml username http://10.70.59.125:8080/auth/realms/realm_name /home/certificate.txt /home/private-key.txtCopy to Clipboard Copied! Toggle word wrap Toggle overflow

置き換え

-

Ceph

mgrノードを使用した CEPH_MGR_NODE。例:ceph-mgr-hostname - CEPH_DASHBOARD_BASE_URL は、Ceph Dashboard にアクセスできるベース URL に置き換えます。

- IDP_METADATA は、リモートパスまたはローカルパス、または IdP メタデータ XML の内容への URL に置き換えます。サポートされる URL タイプは http、https、およびファイルです。

- 任意: IDP_USERNAME_ATTRIBUTE は、認証応答からユーザー名を取得するために使用される属性に置き換えます。デフォルトは uid です。

- 任意: IDP_ENTITY_ID は、IdP メタデータに複数のエンティティー ID が存在する場合は IdP エンティティー ID に置き換えます。

- 任意: SP_X_509_CERT は、署名および暗号化に Ceph Dashboard によって使用される証明書のファイルパスに置き換えます。

- 任意: SP_PRIVATE_KEY は、署名および暗号化に Ceph Dashboard によって使用される秘密鍵のファイルパスに置き換えます。

現在の SAML 2.0 設定を確認します。

ベアメタル デプロイメント:

構文

ceph dashboard sso show saml2

ceph dashboard sso show saml2Copy to Clipboard Copied! Toggle word wrap Toggle overflow コンテナー デプロイメント:

構文

podman exec CEPH_MGR_NODE ceph dashboard sso show saml2

podman exec CEPH_MGR_NODE ceph dashboard sso show saml2Copy to Clipboard Copied! Toggle word wrap Toggle overflow

SSO を有効にするには、以下のコマンドを実行します。

ベアメタル デプロイメント:

構文

ceph dashboard sso enable saml2 SSO is "enabled" with "SAML2" protocol.

ceph dashboard sso enable saml2 SSO is "enabled" with "SAML2" protocol.Copy to Clipboard Copied! Toggle word wrap Toggle overflow コンテナー デプロイメント:

構文

podman exec CEPH_MGR_NODE ceph dashboard sso enable saml2 SSO is "enabled" with "SAML2" protocol.

podman exec CEPH_MGR_NODE ceph dashboard sso enable saml2 SSO is "enabled" with "SAML2" protocol.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

ダッシュボードの URL を開きます。以下は例になります。

http://dashboard_hostname.ceph.redhat.com:8443

http://dashboard_hostname.ceph.redhat.com:8443Copy to Clipboard Copied! Toggle word wrap Toggle overflow - SSO ページで、ログインの認証情報を入力します。SSO はダッシュボードの Web インターフェイスにリダイレクトされます。

関連情報

- シングルサインオンを無効にするには、Red Hat Ceph Storage ダッシュボードガイドの DCeph Dashboard のシングルサインオンの無効化 を参照してください。

2.11. Ceph Dashboard のシングルサインオンの無効化

Ceph Dashboard のシングルサインオンを無効にできます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスター

- Ceph Dashboard ソフトウェアのインストール

- Dashboard を起動します。

- Ceph Manager ノードへのルートレベルのアクセス。

- Ceph Dashboard で有効になっているシングルサインオン

以下のライブラリーパッケージを Ceph Manager ノードにインストールします。

-

python3-saml -

python3-defusedxml -

python3-isodate -

python3-xmlsec

-

手順

SSO の状態を表示するには、以下のコマンドを実行します。

ベアメタル デプロイメント:

構文

ceph dashboard sso status SSO is "enabled" with "SAML2" protocol.

ceph dashboard sso status SSO is "enabled" with "SAML2" protocol.Copy to Clipboard Copied! Toggle word wrap Toggle overflow コンテナー デプロイメント:

構文

podman exec CEPH_MGR_NODE ceph dashboard sso status SSO is "enabled" with "SAML2" protocol.

podman exec CEPH_MGR_NODE ceph dashboard sso status SSO is "enabled" with "SAML2" protocol.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 置き換え

-

Ceph

mgrノードを使用した CEPH_MGR_NODE。例:ceph-mgr-hostname

-

Ceph

SSO を無効にするには、以下のコマンドを実行します。

ベアメタル デプロイメント:

構文

ceph dashboard sso disable SSO is "disabled".

ceph dashboard sso disable SSO is "disabled".Copy to Clipboard Copied! Toggle word wrap Toggle overflow コンテナー デプロイメント:

構文

podman exec CEPH_MGR_NODE ceph dashboard sso disable SSO is "disabled".

podman exec CEPH_MGR_NODE ceph dashboard sso disable SSO is "disabled".Copy to Clipboard Copied! Toggle word wrap Toggle overflow 置き換え

-

Ceph

mgrノードを使用した CEPH_MGR_NODE。例:ceph-mgr-hostname

-

Ceph

関連情報

- シングルサインオンを有効にするには、Red Hat Ceph Storage ダッシュボードガイドの Ceph Dashboard のシングルサインオンの有効化 を参照してください。

第3章 ダッシュボードでのロールの管理

ストレージ管理者は、ダッシュボードでロールを作成、表示、編集、および削除することができます。ロールにパーミッションを付与でき、ユーザーに特定のロールを割り当てることができます。

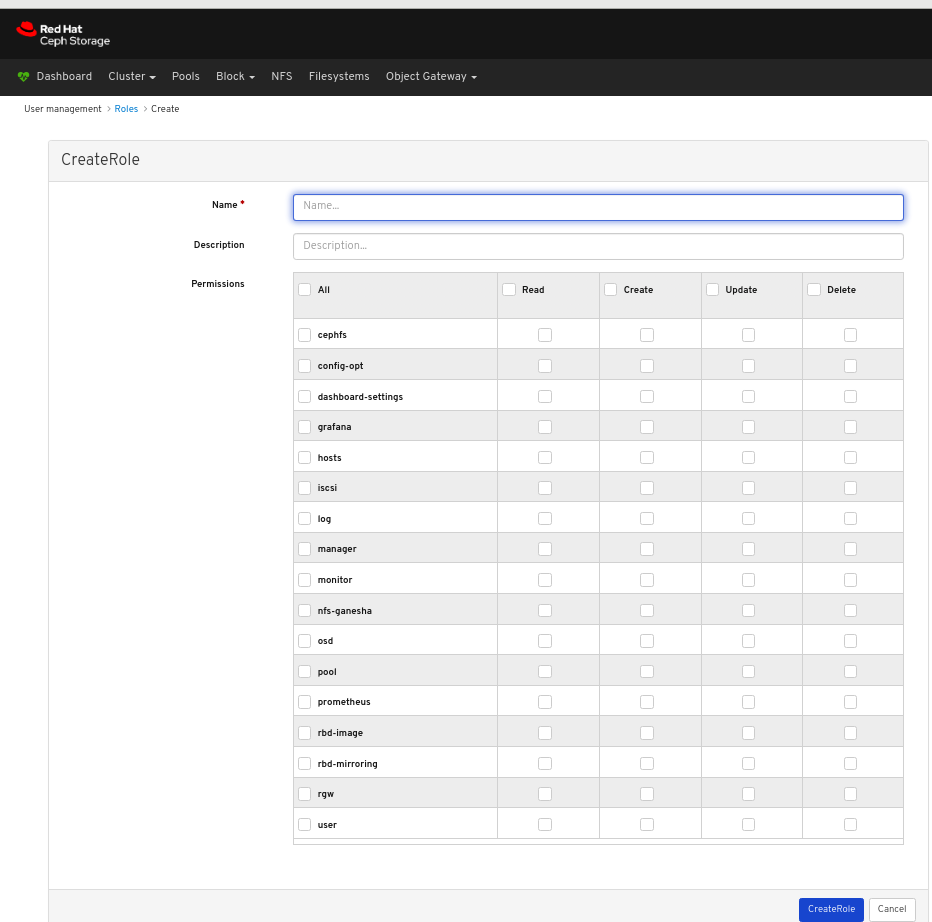

3.1. ダッシュボードでのロールの作成

ダッシュボードでは、ユーザーに割り当て可能なダッシュボードでロールを作成できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Dashboard への管理者アクセスレベル。

手順

- Dashboard にログインします。

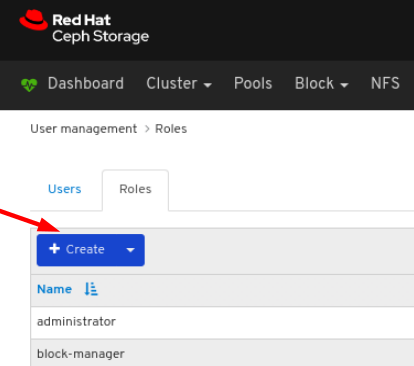

Dashboard の右上にある歯車アイコンをクリックして、ユーザー管理 を選択します。

Roles タブで、Create ボタンをクリックします。

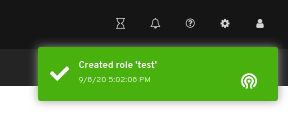

CreateRole ウィンドウで Name を設定し、このロールの Permissions を選択してから CreateRole ボタンをクリックします。

ページの右上隅に対する通知は、ロールが正常に作成されたことを示します。

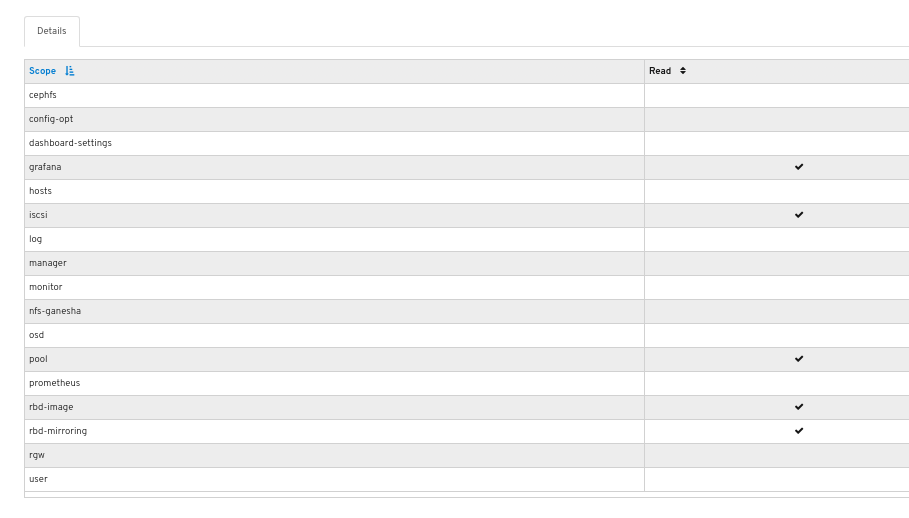

3.2. ダッシュボードでのロールの表示

ダッシュボードでは、ダッシュボード上のロールの詳細を表示できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- ダッシュボードへの管理者アクセスレベル。

- ロールがダッシュボードに作成されている。

手順

- Dashboard にログインします。

Dashboard の右上にある歯車アイコンをクリックして、ユーザー管理 を選択します。

ロールの詳細を表示するには、その行をクリックします。

ロールに提供されるパーミッションの詳細が表示されます。

関連情報

- 詳細は、Red Hat Ceph Storage ダッシュボードガイドの ダッシュボードでロールの作成 セクションを参照してください。

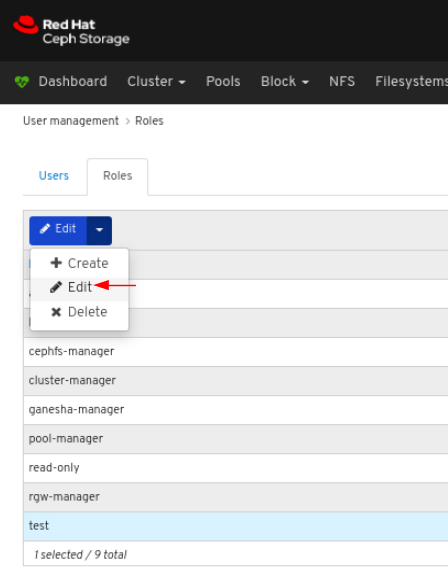

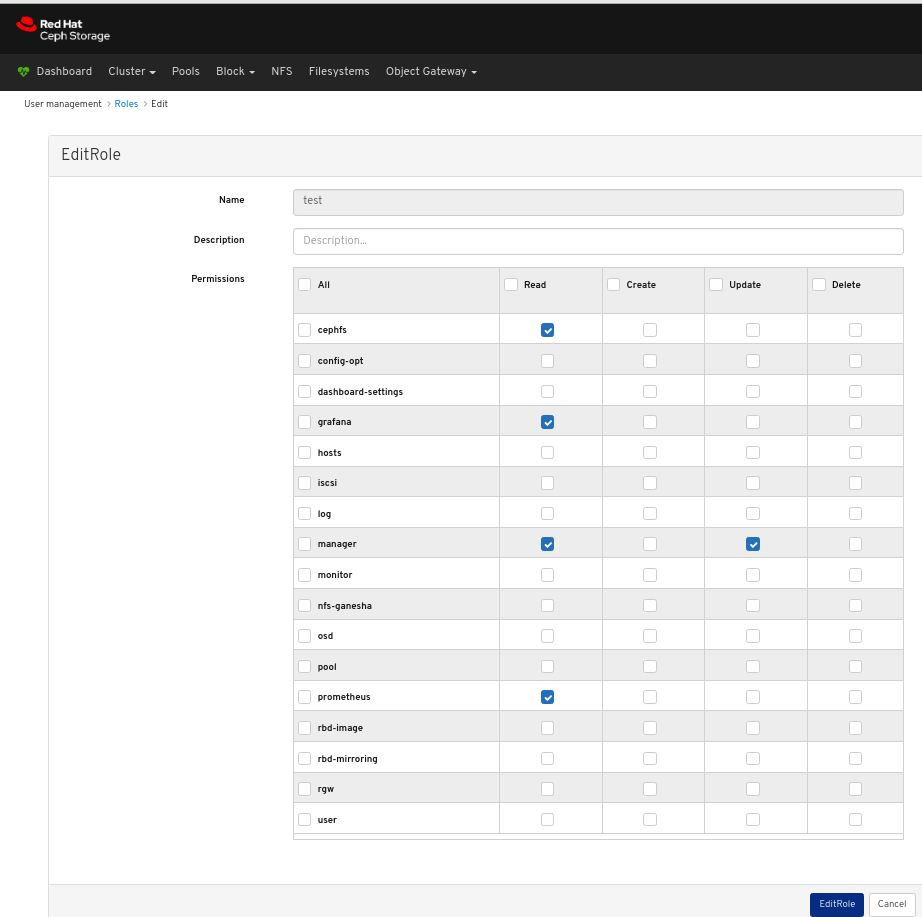

3.3. ダッシュボードでのロールの編集

ダッシュボードでは、ダッシュボードのロールを編集できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Dashboard への管理者アクセスレベル。

- ダッシュボードでロールが作成されます。

手順

- Dashboard にログインします。

Dashboard の右上にある歯車アイコンをクリックして、ユーザー管理 を選択します。

ロールを編集するには、行をクリックします。

Roles タブで、Edit ドロップダウンメニューの Edit を選択します。

EditRole ウィンドウで、が含まれるパラメーターを編集して、EditRole ボタンをクリックします。

ページの右上隅に対する通知は、ロールが正常に更新されたことを示します。

関連情報

- 詳細は、Red Hat Ceph Storage ダッシュボードガイドの ダッシュボードでロールの作成 セクションを参照してください。

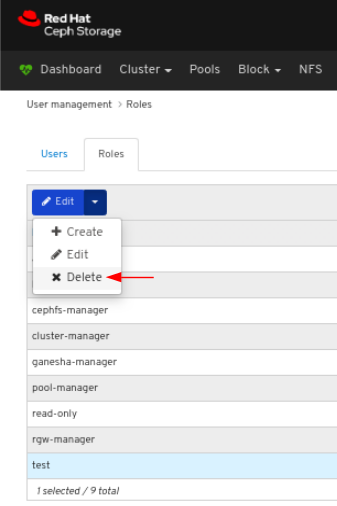

3.4. ダッシュボード上のロールの削除

ダッシュボードで、ダッシュボードのロールを削除できます。

削除できるのは、作成したロールのみです。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Dashboard への管理者アクセスレベル。

- ダッシュボードでロールが作成されます。

手順

- Dashboard にログインします。

Dashboard の右上にある歯車アイコンをクリックして、ユーザー管理 を選択します。

ロールを削除するには、行をクリックします。

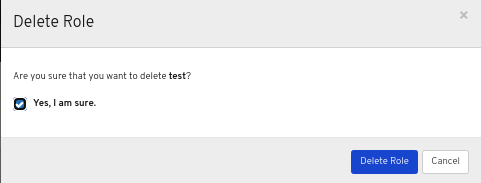

Roles タブで、Edit ドロップダウンメニューの Delete を選択します。

Delete Role ダイアログウィンドウで Yes, I am sure ボックスをクリックして Delete Role をクリックして設定を保存します。

関連情報

- 詳細は、Red Hat Ceph Storage ダッシュボードガイドの ダッシュボードでロールの作成 セクションを参照してください。

第4章 ダッシュボードでのユーザーの管理

ストレージ管理者は、ダッシュボードでユーザーを作成、編集、および削除できます。

4.1. ダッシュボードでのユーザーの作成

ダッシュボードで、ダッシュボードにユーザーを作成できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Dashboard への管理者アクセスレベル。

Red Hat Ceph Storage Dashboard は、ユーザーパスワードの変更時に電子メールの検証をサポートしません。Dashboard はシングルサインオン (SSO) をサポートし、この機能を SSO プロバイダーに委譲できるため、この動作は意図的です。

手順

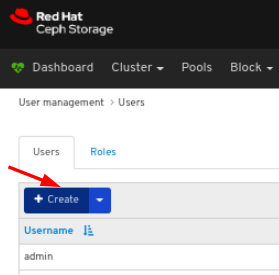

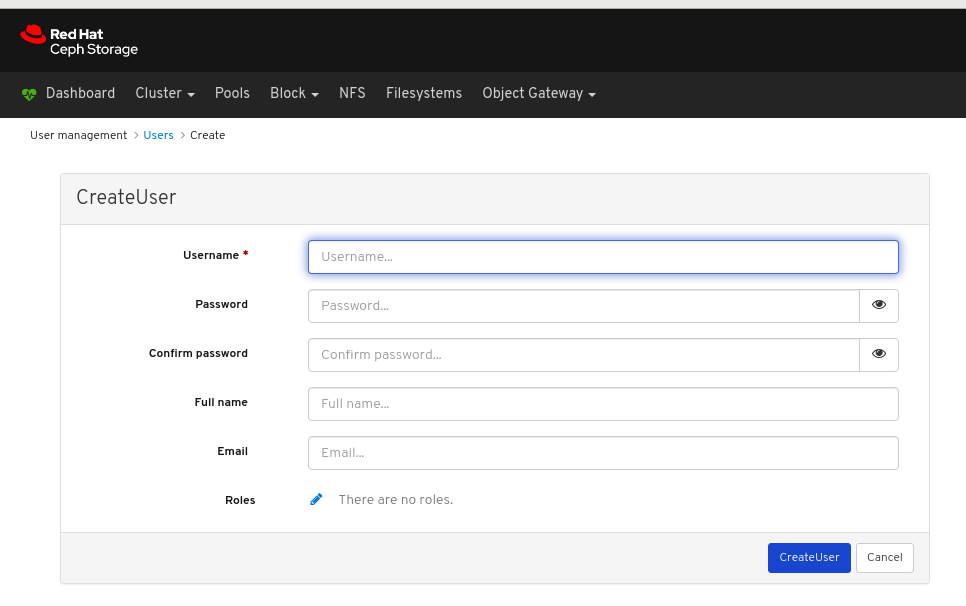

- Dashboard にログインします。

Dashboard の右上にある歯車アイコンをクリックして、ユーザー管理 を選択します。

Users タブで Create ボタンをクリックします。

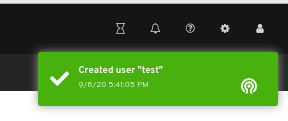

CreateUser ウィンドウで、ロールを含む Username およびその他のパラメーターを設定し、CreateUser ボタンをクリックします。

ページの右上隅に対する通知は、ユーザーが正常に作成されたことを示しています。

関連情報

- 詳細は、Red Hat Ceph Storage ダッシュボードガイドの ダッシュボードへのロールの作成 セクションを参照してください。

4.2. ダッシュボードでのユーザーの編集

ダッシュボードでは、ダッシュボードのユーザーを編集できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Dashboard への管理者アクセスレベル。

- ダッシュボードで作成したユーザー。

手順

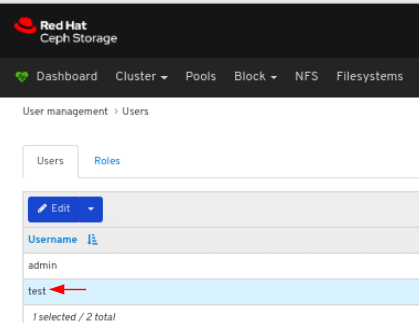

- Dashboard にログインします。

Dashboard の右上にある歯車アイコンをクリックして、ユーザー管理 を選択します。

ユーザーを編集するには、行をクリックします。

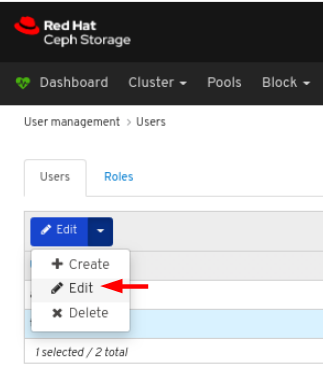

Users タブで、Edit ドロップダウンメニューで Edit を選択します。

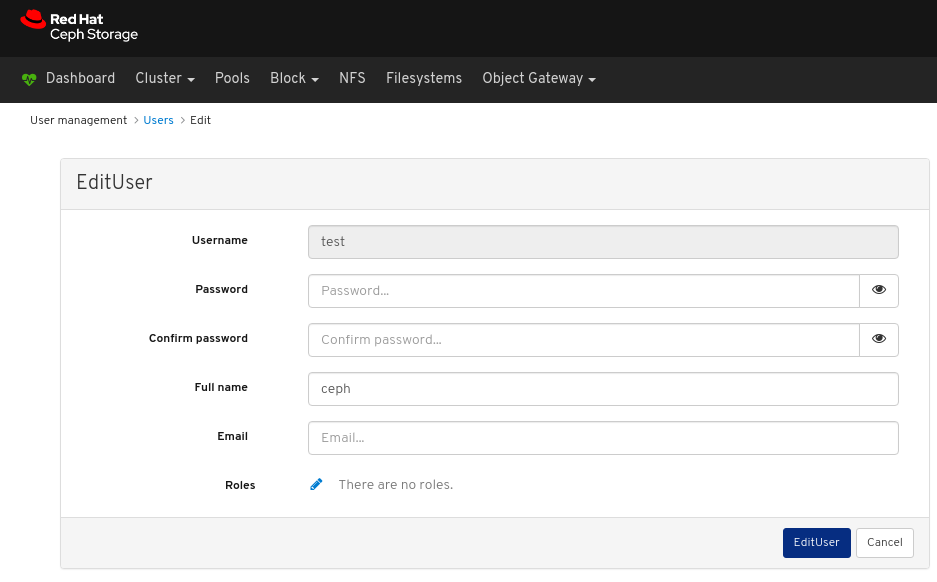

EditUser ウィンドウで、が含まれるパラメーターを編集して、EditUser ボタンをクリックします。

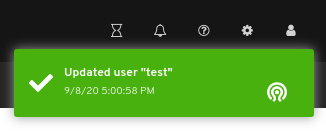

ページの右上隅に対する通知は、ユーザーが正常に更新されたことを示しています。

関連情報

- 詳細は、Red Hat Ceph Storage ダッシュボードガイドの Dashboard にユーザーの作成 セクションを参照してください。

4.3. ダッシュボードでのユーザーの削除

ダッシュボードで、ダッシュボードのユーザーを削除できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Dashboard への管理者アクセスレベル。

- ダッシュボードで作成したユーザー。

手順

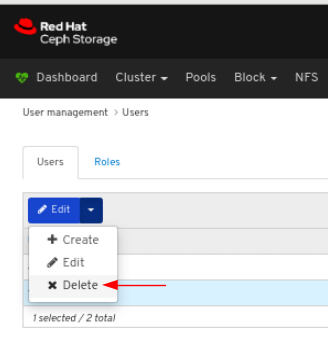

- Dashboard にログインします。

Dashboard の右上にある歯車アイコンをクリックして、ユーザー管理 を選択します。

ユーザーを削除するには、行をクリックします。

Users タブで、Edit ドロップダウンメニューの Delete を選択します。

Delete User ダイアログウィンドウで Yes, I am sure ボックスをクリックして Delete user をクリックし、設定を保存します。

関連情報

- 詳細は、Red Hat Ceph Storage ダッシュボードガイドの Dashboard にユーザーの作成 セクションを参照してください。

第5章 クラスターの監視

ダッシュボードの監視機能は、ストレージクラスターのさまざまな側面を示すために定期的に更新するさまざまな Web ページを提供します。ランディングページを使用してクラスターの全体的な状態を監視したり、ブロックデバイスイメージの状態など、クラスターの特定の機能を監視したりできます。

関連情報

- 詳細は、ダッシュボードガイド の ランディングページへのアクセス を参照してください。

- 詳細は、ダッシュボードガイド の ランディングページの理解 を参照してください。

- 詳細は、ダッシュボードガイド の 特定の機能の監視 を参照してください。

5.1. ランディングページへのアクセス

ダッシュボードにログインすると、ランディングページが読み込まれます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

手順

Dashboard にログインします。

ダッシュボードにログインすると、ランディングページが読み込まれます。

他のダッシュボードページを表示した後にランディングページに戻るには、ページの左上隅にある Dashboard をクリックします。

関連情報

- 詳細は、ダッシュボードガイド の ランディングページの理解 を参照してください。

- 詳細は、ダッシュボードガイド の 特定の機能の監視 を参照してください。

5.2. ランディングページについて

ランディングページには、個別のパネルを使用した Ceph クラスター全体の概要が表示されます。各パネルに、クラスターの状態に関する具体的な情報が表示されます。

カテゴリー

ランディングページでは、パネルが以下の 3 つのカテゴリーに分けられます。

- 状態

- 容量

- パフォーマンス

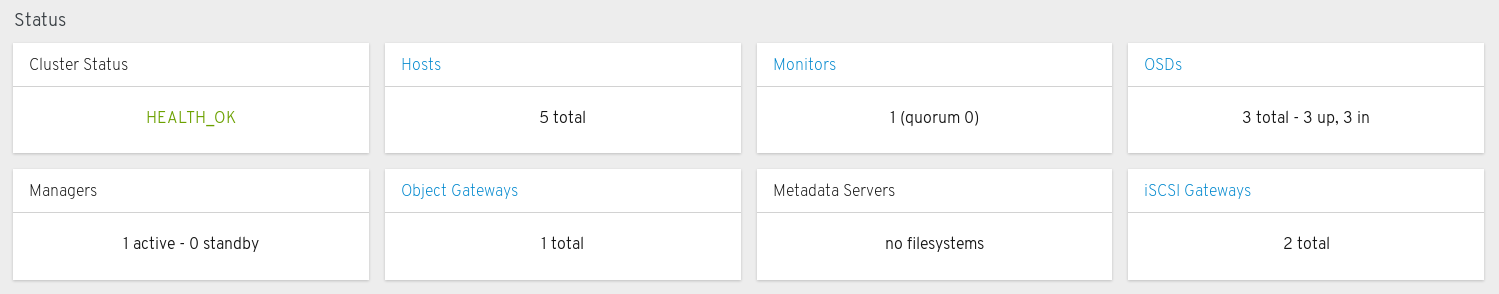

Status パネル

ステータスパネルには、クラスターの状態とホストおよびデーモンの状態が表示されます。

クラスターの状態: Ceph クラスターの現在の健常性ステータスを表示します。

ホスト: Ceph Storage クラスターのホストの合計数を表示します。

監視: Ceph Monitor の数およびクォーラムのステータスを表示します。

OSDs: Ceph Storage クラスターの OSD の合計数と、up および in の数を表示します。

マネージャー: Manager Daemon の数およびステータスを表示します。

Object Gateway : Ceph Storage クラスターのObject Gateway の数を表示します。

メタデータサーバー: Ceph ファイルシステムのメタデータサーバーの数およびステータスを表示します。

iSCSI ゲートウェイ: Ceph ストレージクラスター内の iSCSI ゲートウェイの数を表示します。

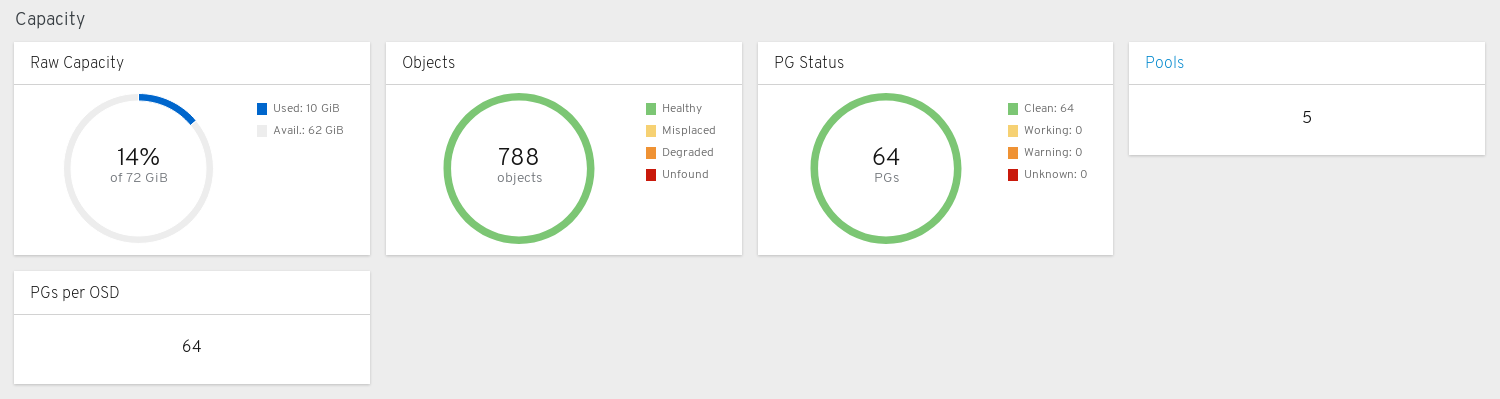

容量パネル

容量パネルには、ストレージ使用状況のメトリックが表示されます。

Raw 容量: クラスターの raw ストレージ容量の使用状況および可用性を表示します。

オブジェクト: プール内のオブジェクトの合計数と、オブジェクトを Healthy、Misplaced、Degraded、または Unfound の状態に分割するグラフを表示します。

PG ステータス: 配置グループの合計数と、PG を Clean、Working、Warning、または Unknown の状態に分割するグラフを表示します。PG ステータスの Working および Warning の表示を簡素化するために、実際には複数の状態が含まれます。

Working の状態には、以下のいずれかの状態の PG が含まれます。

- activating

- backfill_wait

- backfilling

- creating

- deep

- degraded

- forced_backfill

- forced_recovery

- peering

- peered

- recovering

- recovery_wait

- repair

- scrubbing

- snaptrim

- snaptrim_wait

Warning の状態には、以下のいずれかの状態の PG が含まれます。

- backfill_toofull

- backfill_unfound

- down

- incomplete

- inconsistent

- recovery_toofull

- recovery_unfound

- remapped

- snaptrim_error

- stale

- undersized

プール: Ceph クラスター内のストレージプールの数を表示します。

OSD ごとの PG: OSD ごとの配置グループ数を表示します。

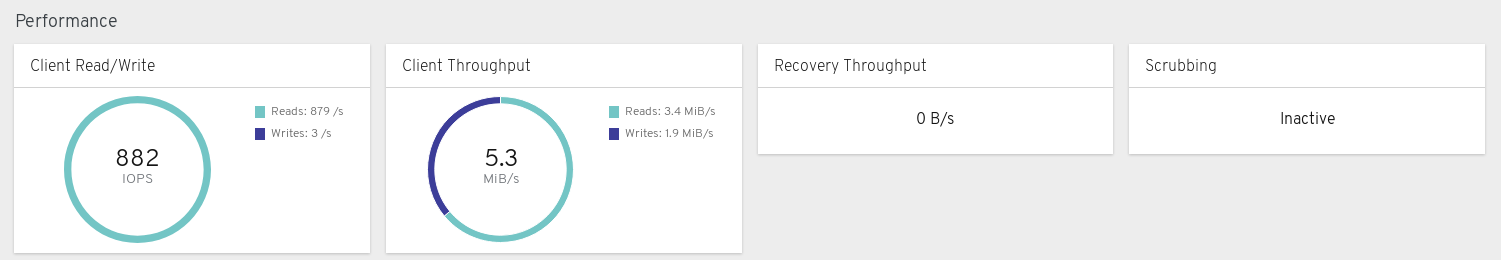

パフォーマンスパネル

パフォーマンスパネルには、データ転送速度に関する情報が表示されます。

クライアントの読み取り/書き込み: 1 秒あたりの入出力操作の合計、読み取り、および書き込みを表示します。

クライアントのスループット: クライアントスループット、読み取りスループット、書き込みスループットを表示します。

リカバリーのスループット: クライアントのリカバリー速度を表示します。

スクラビング: データの整合性を確認するために Ceph がスクラビングしているかどうかを表示します。

関連情報

- 詳細は、ダッシュボードガイド の ランディングページへのアクセス を参照してください。

- 詳細は、ダッシュボードガイド の 特定の機能の監視 を参照してください。

第6章 特定の機能の監視

ストレージ管理者は、Red Hat Ceph Storage Dashboard を使用して、ホスト、サービス、データアクセスメソッドなどに基づいてクラスターの特定の要素を監視できます。

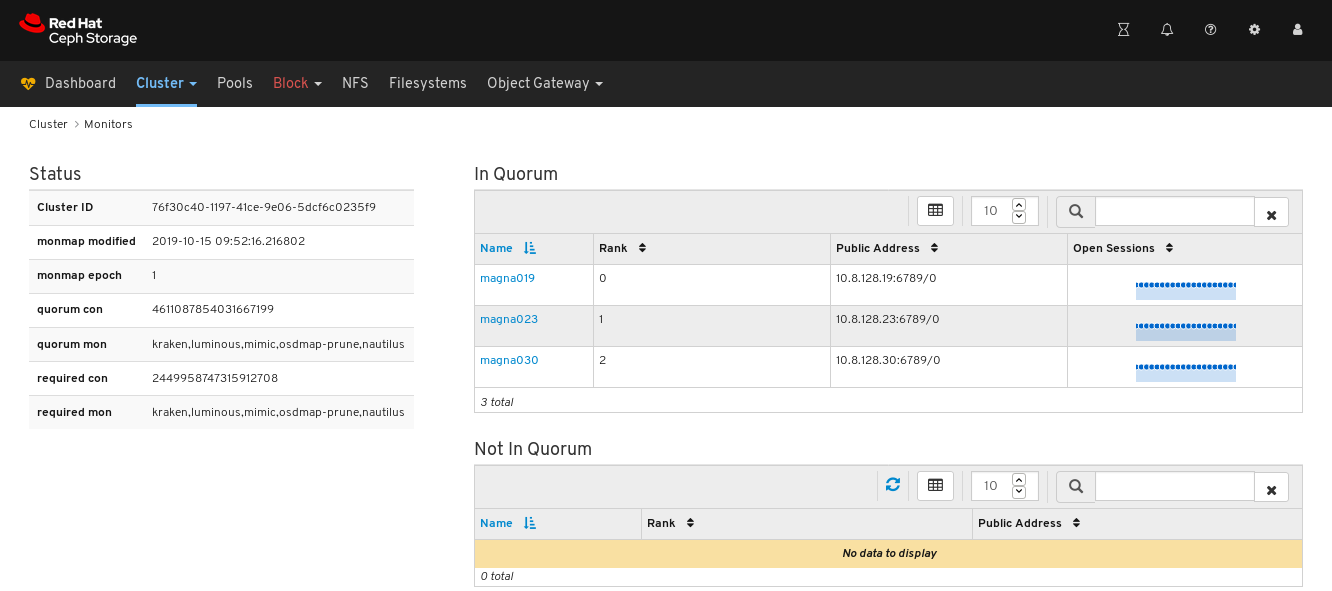

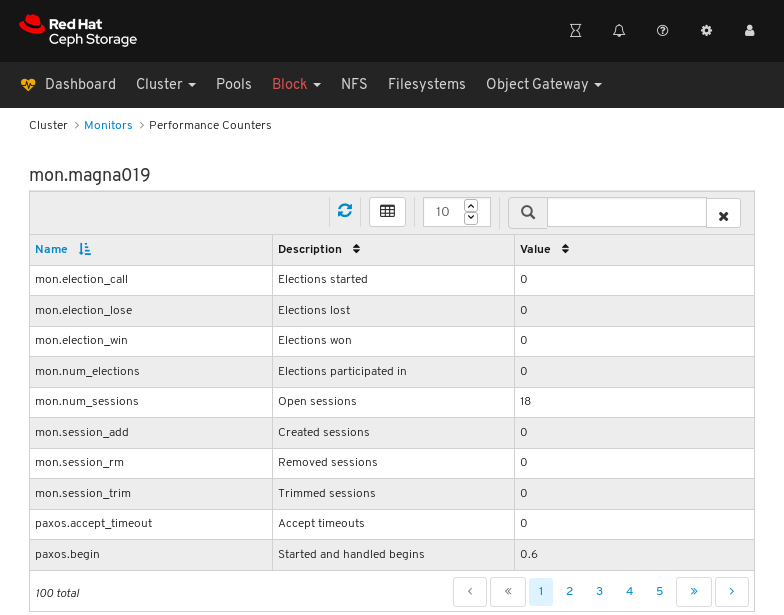

6.1. モニターの監視

Red Hat Ceph Storage Dashboard では、Monitor ノードに関するさまざまな情報を表示できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

手順

- ダッシュボードにログインします。

- ナビゲーションバーで Cluster をクリックし、Monitors をクリックします。

Monitors 概要ページには、全体的な監視ステータスに関する情報と、Monitor ノード in Quorum および Not in quorum のテーブルが表示されます。

開いているセッションの数を確認するには、青い点線のトレイルにカーソルを合わせます。

モニターのパフォーマンスカウンターを表示するには、ホスト名をクリックします。

パフォーマンスカウンターを表示します。

関連情報

- Monitor の詳細は、Operations ガイド の Ceph モニター を参照してください。

- パフォーマンスカウンターの詳細は、管理ガイド の パフォーマンスカウンター を参照してください。

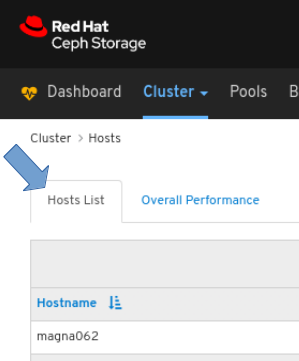

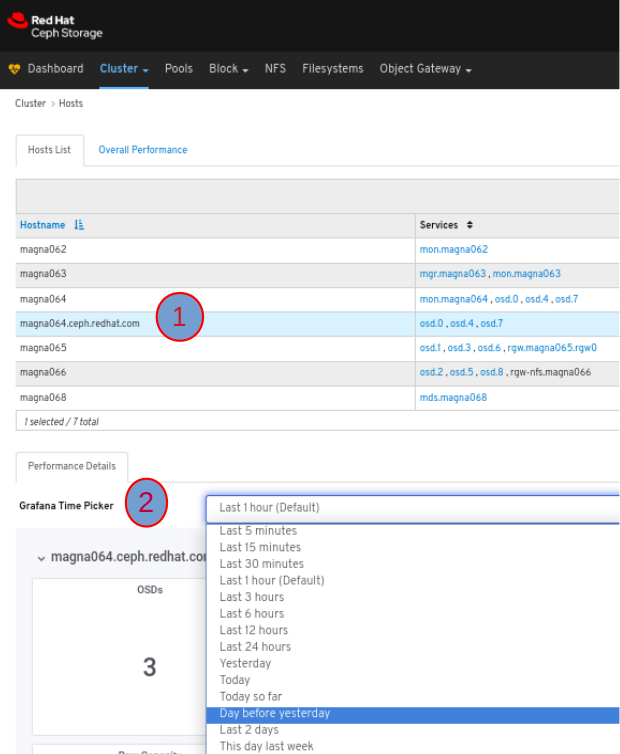

6.2. ホストの監視

Red Hat Ceph Storage Dashboard では、ホストに関するさまざまな情報を表示できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

手順

- ダッシュボードにログインします。

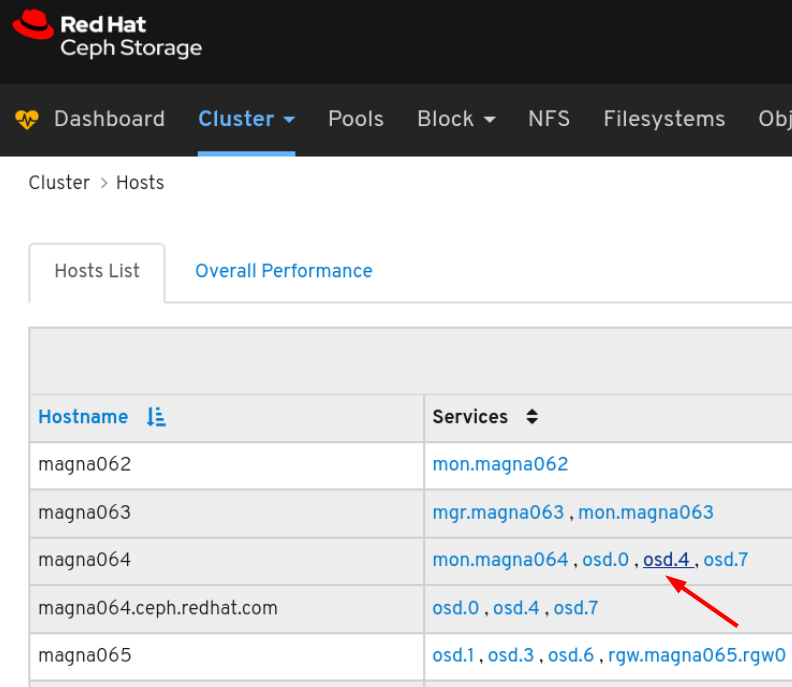

- ナビゲーションバーで Cluster をクリックし、Hosts をクリックします。

ホストの一覧を表示するには、Hosts List タブをクリックします。

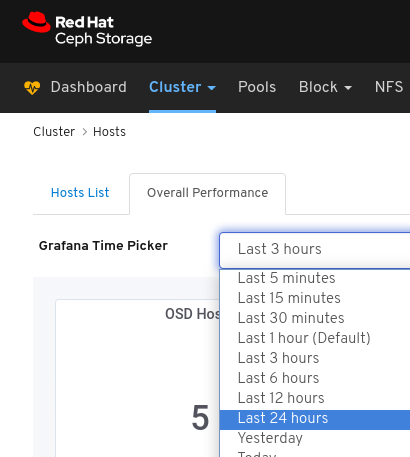

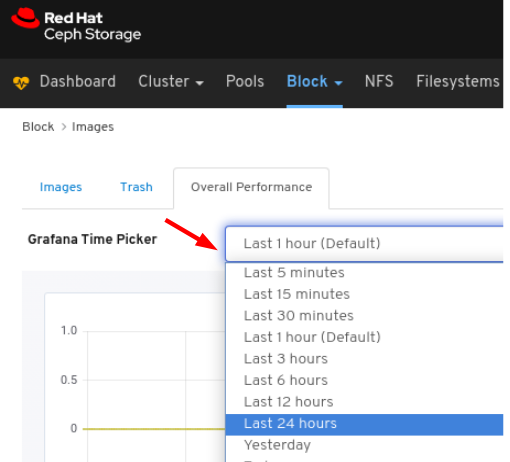

ホストの パフォーマンスの詳細 を表示するには、Host タブでその行をクリックし、Grafana Time Picker ドロップダウンメニューから時間の範囲を選択します。

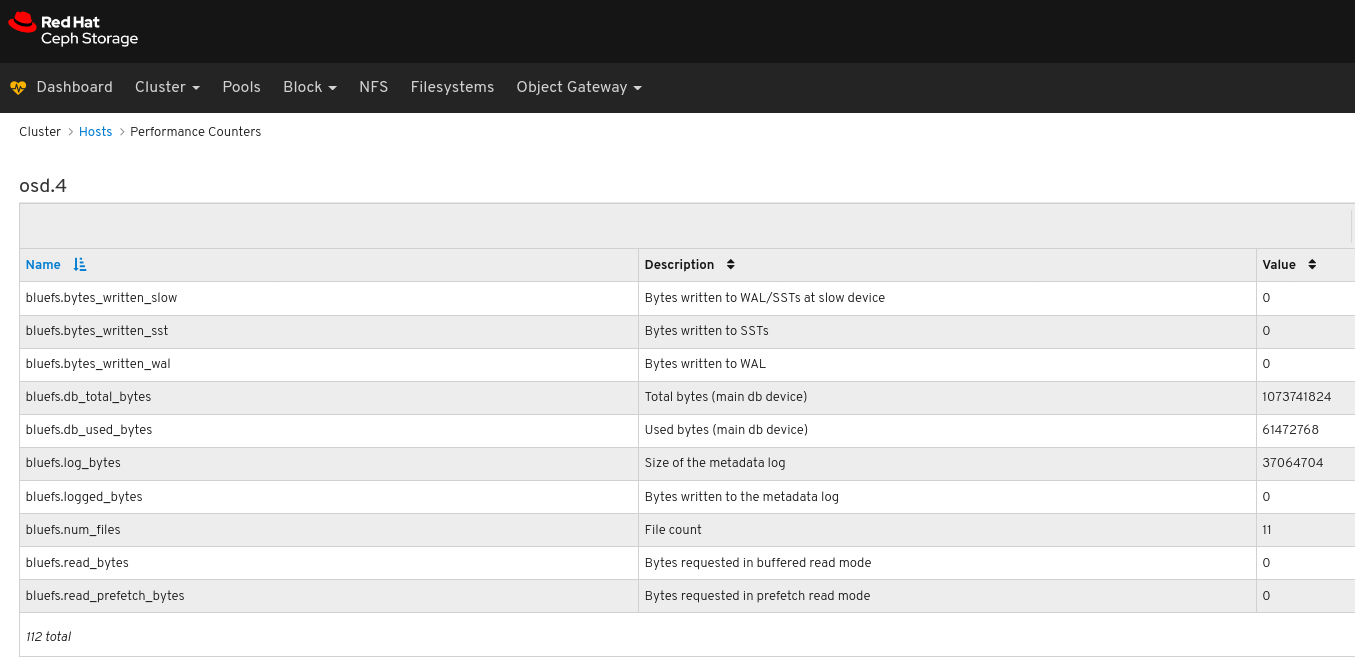

ホスト上の特定サービスのパフォーマンスカウンターを表示するには、サービスをクリックします。

パフォーマンスカウンターを表示します。

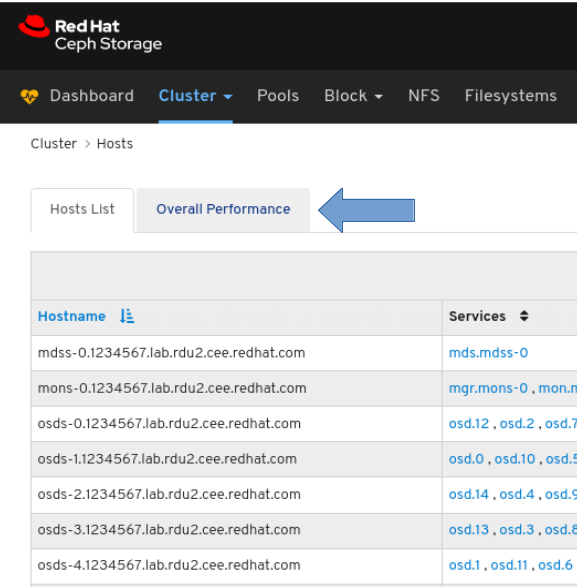

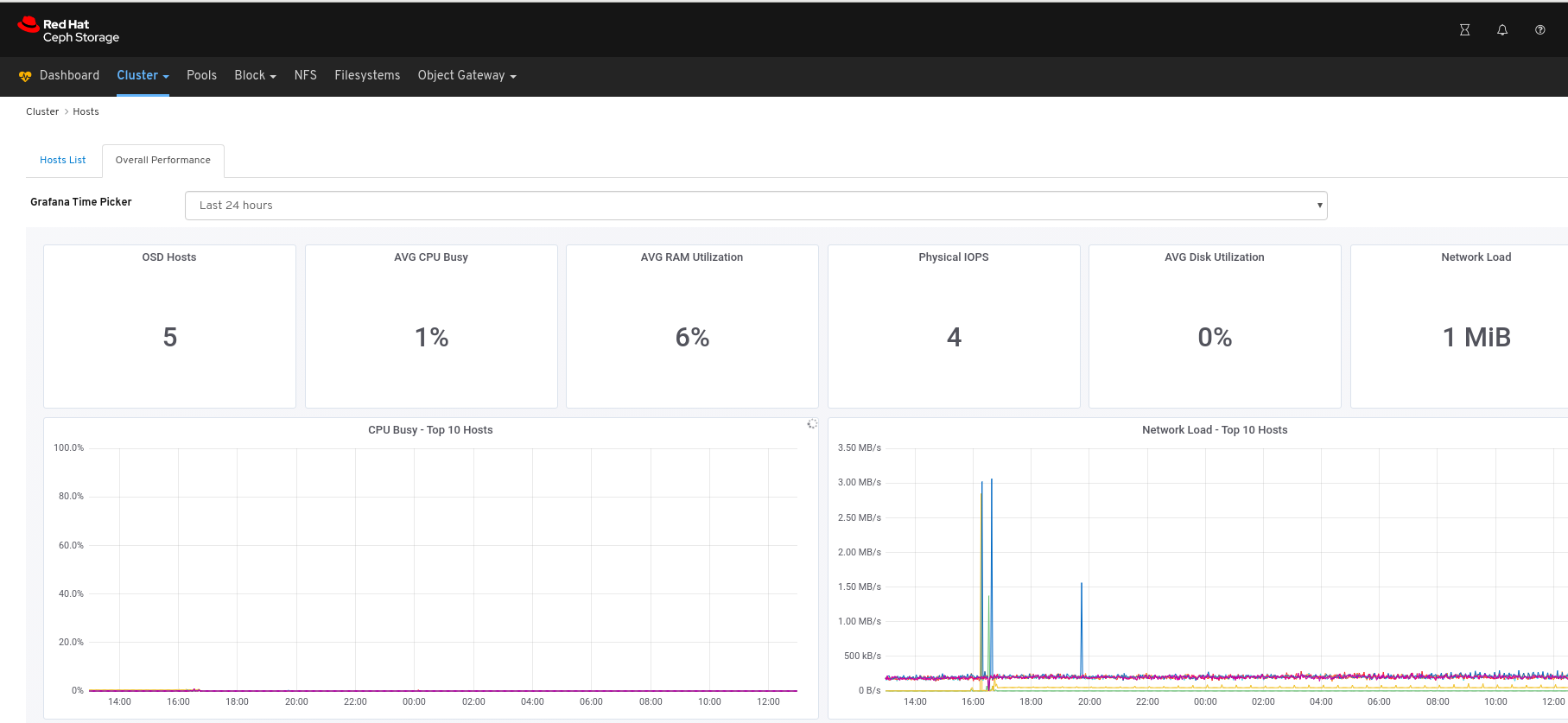

すべてのホストのパフォーマンスデータを表示するには、次を実行します。

ページの左上にある Overall Performance タブをクリックします。

Grafana Time Picker ドロップダウンから時間の範囲を選択します。

Overall Performance ページを表示します。

関連情報

- 詳細は、Red Hat Ceph Storage 管理ガイドの パフォーマンスカウンター を参照してください。

6.3. OSD のモニタリング

Red Hat Ceph Storage Dashboard では、OSD に関するさまざまな情報を表示できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

手順

- ダッシュボードにログインします。

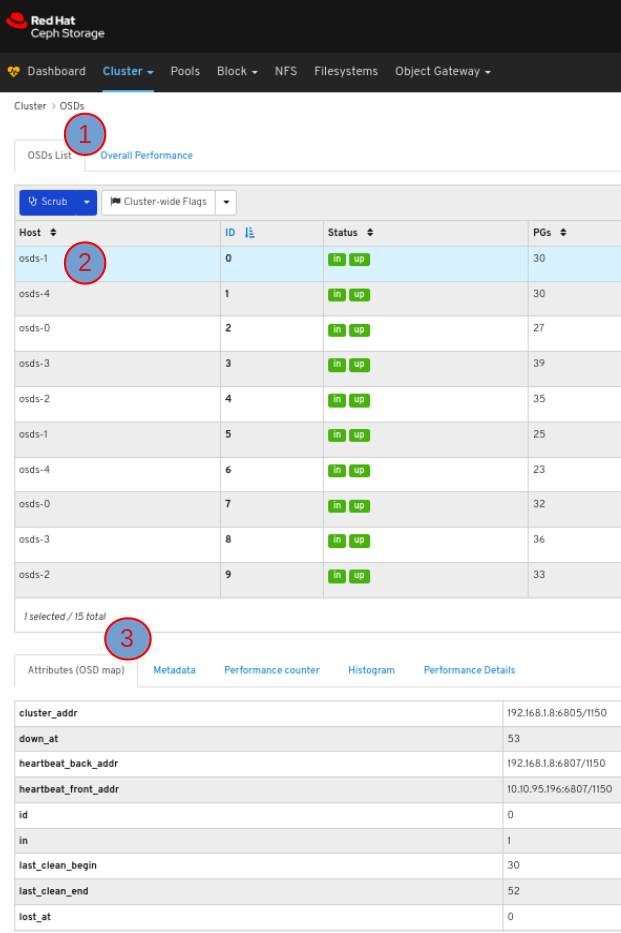

- ナビゲーションバーで Cluster をクリックし、OSDs をクリックします。

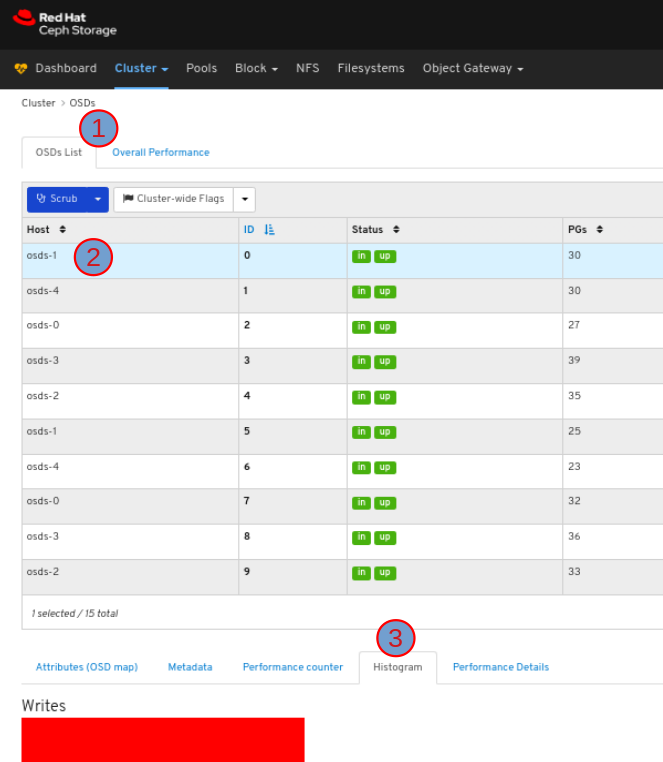

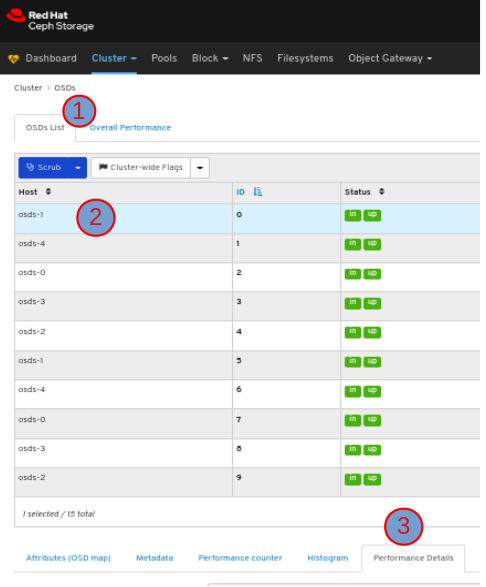

OSD の一覧を表示するには、OSDs List タブをクリックします。

OSD の属性を表示するには、OSDS List タブでその行をクリックします。

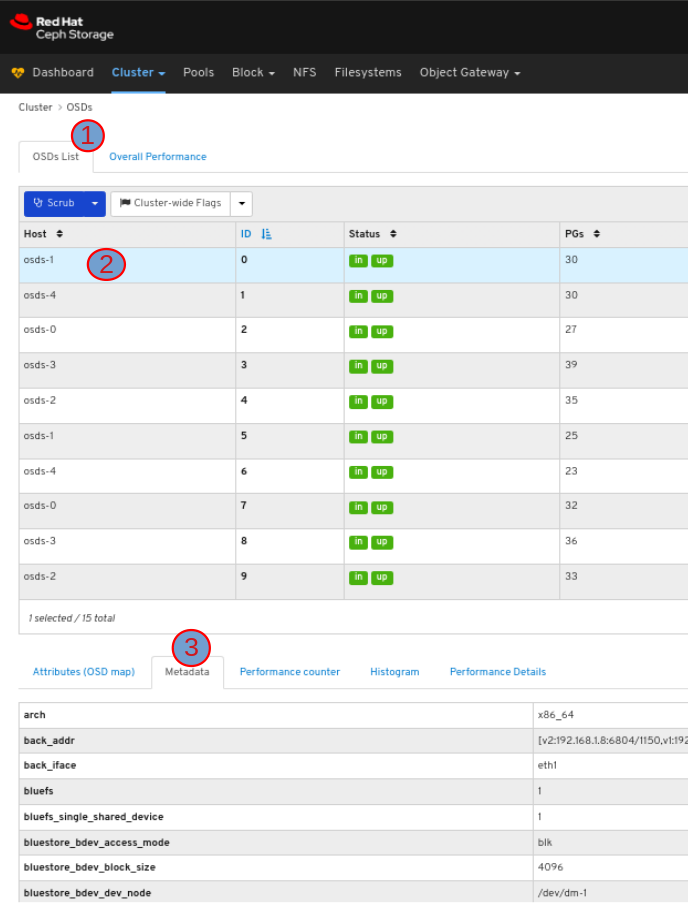

OSD のメタデータを表示するには、OSDs タブでその行をクリックし、Metadata タブをクリックします。

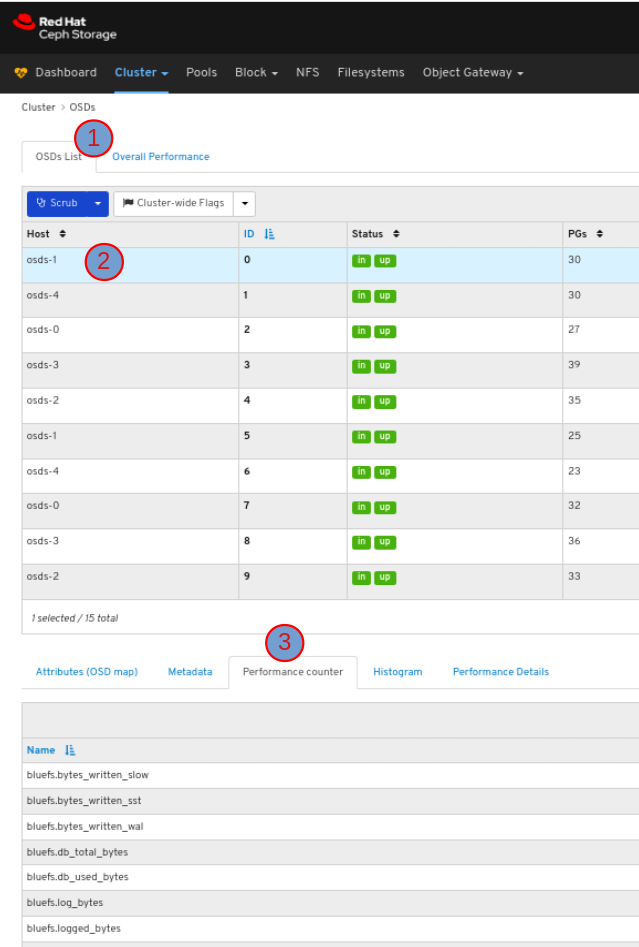

OSD のパフォーマンスカウンターを表示するには、OSDs タブでその行をクリックし、Performance counter タブをクリックします。

OSD のヒストグラムを表示するには、OSDs タブでその行をクリックし、Histogram タブをクリックします。

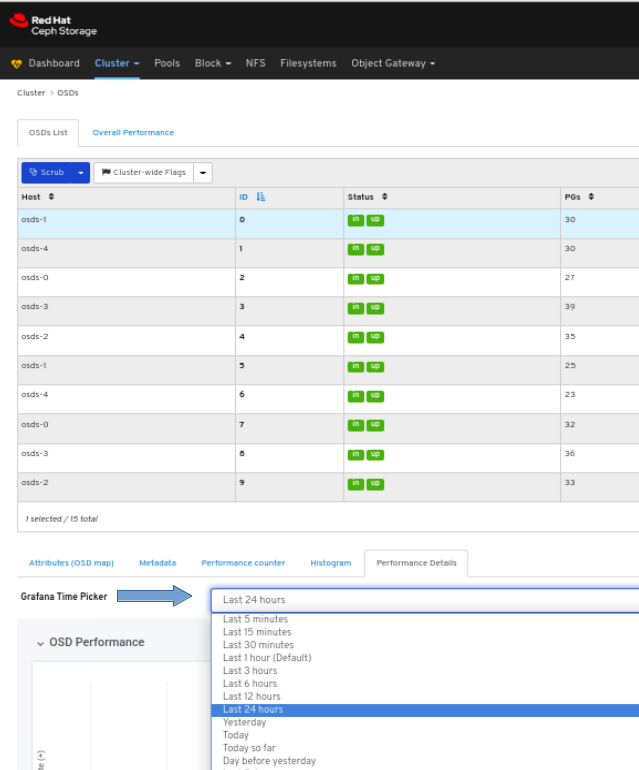

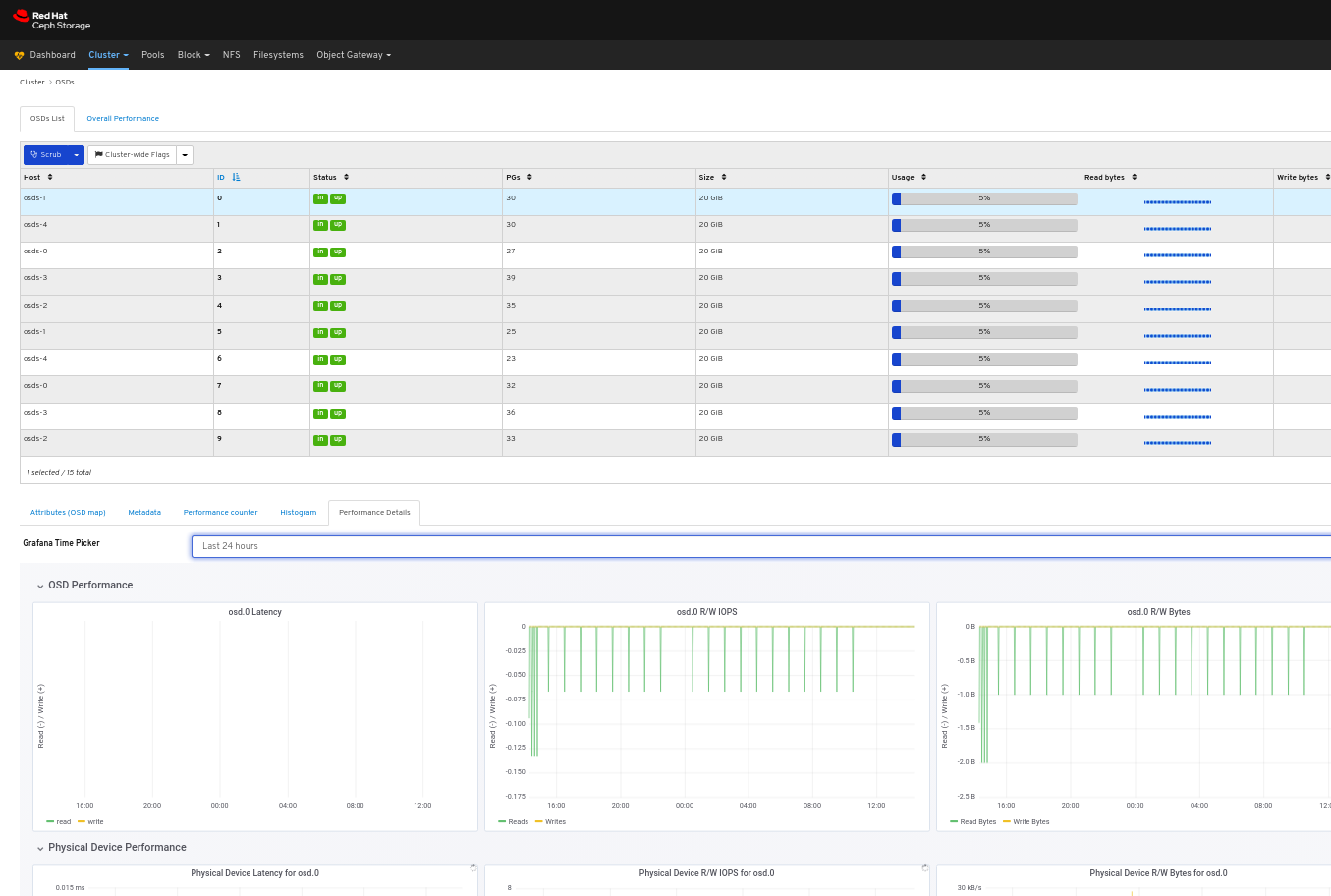

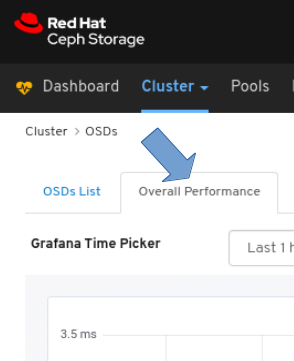

OSD のパフォーマンス情報を表示するには、以下を実行します。

OSDs タブでその行をクリックし、Performance Details タブをクリックします。

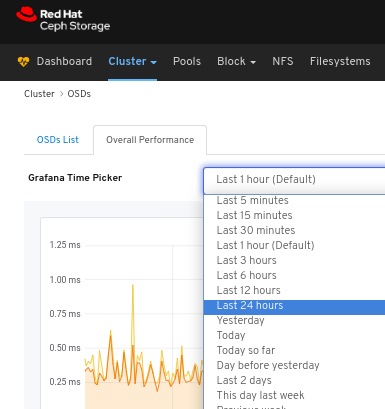

Grafana Time Picker ドロップダウンメニューから時間の範囲を選択します。

OSD のパフォーマンス情報を表示します。

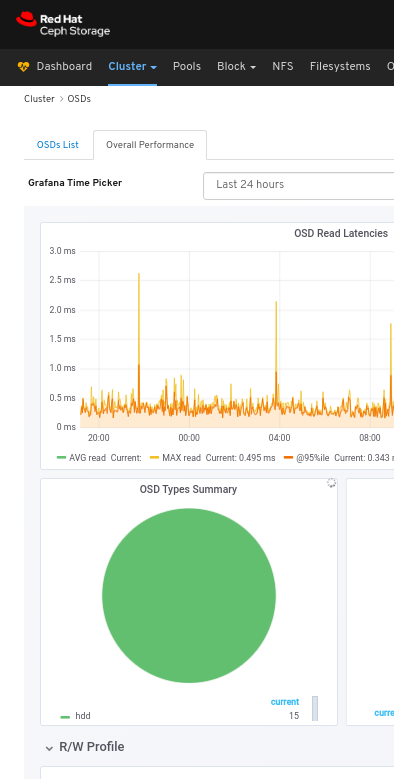

すべての OSD の全体的なパフォーマンスを表示するには、以下を実行します。

ページの左上にあるOverall Performance タブをクリックします。

Grafana Time Picker ドロップダウンから時間の範囲を選択します。

Overall Performance ページを表示します。

関連情報

- 詳細は、Red Hat Ceph Storage 管理ガイドの パフォーマンスカウンター を参照してください。

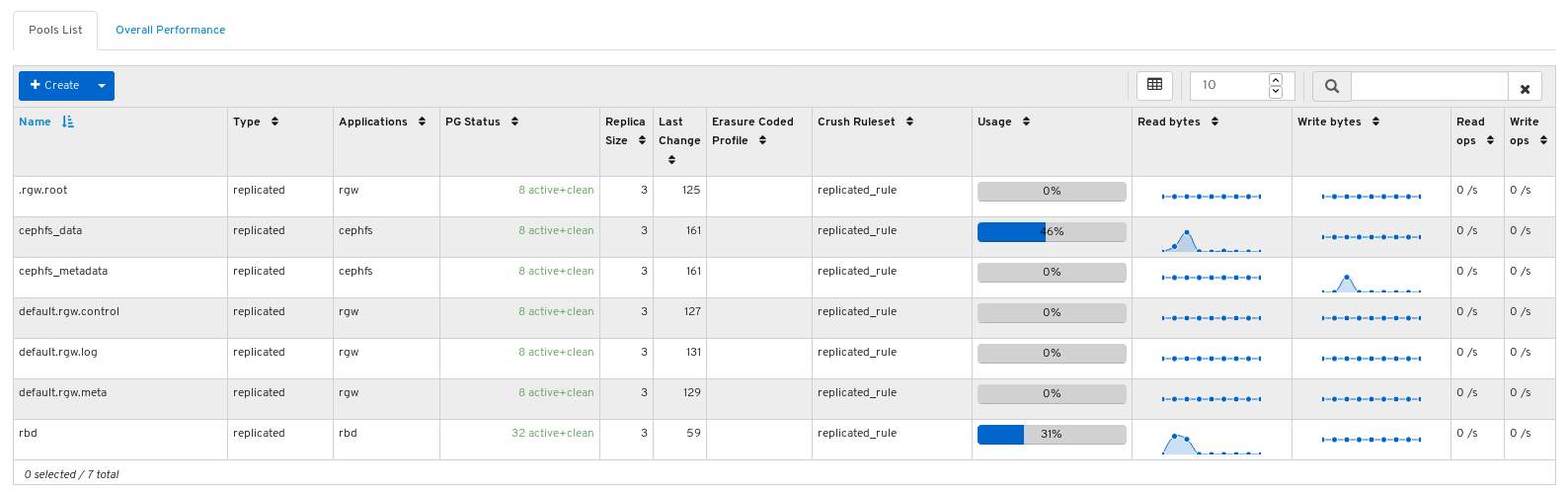

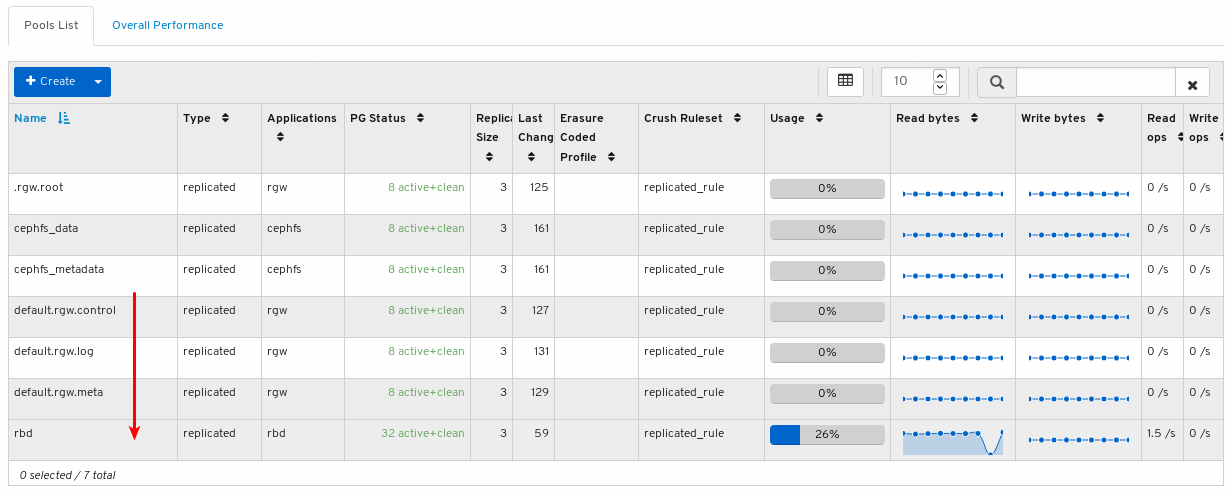

6.4. プールの監視

Red Hat Ceph Storage Dashboard では、クラスター内のプールに関するさまざまな情報を表示できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

手順

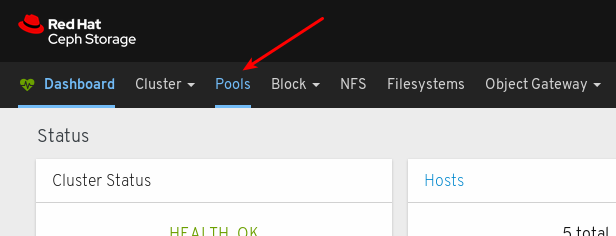

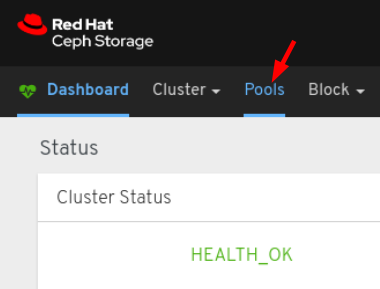

- ダッシュボードにログインします。

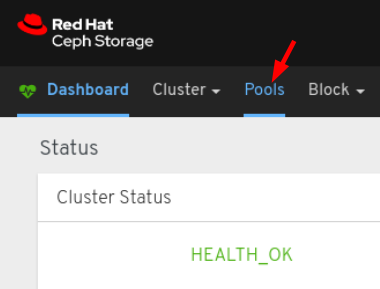

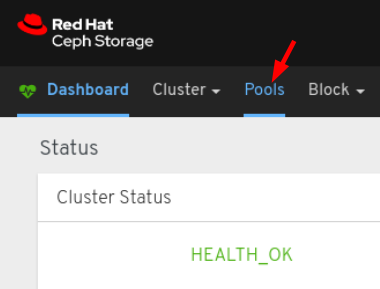

ナビゲーションバーで、Pools をクリックします。

プールの一覧を表示します。

使用状況バーグラフの上にマウスをかざすと、実際に使用されている領域および空き領域が表示されます。

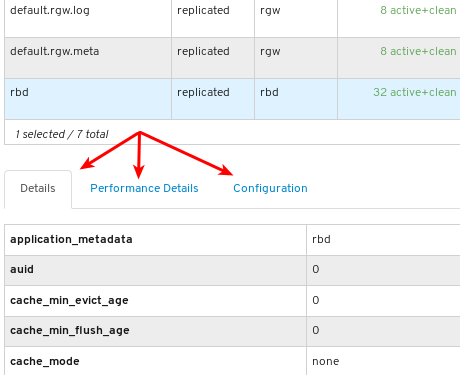

プールに関する詳細情報を表示するには、行をクリックしてそのプールを選択します。

プールの詳細を表示します。プールのパフォーマンスの詳細および設定データを表示するには、関連するタブをクリックします。

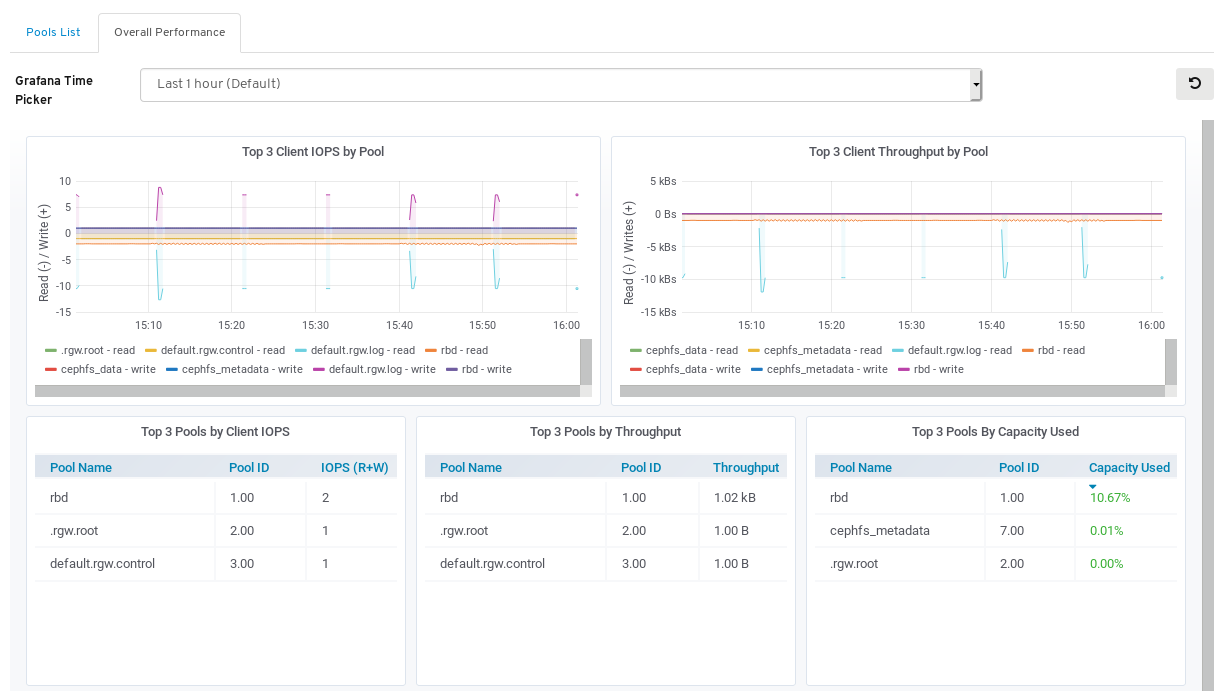

すべてのプールのパフォーマンスデータを表示するには、ページの左上にある Overall Performance タブをクリックします。

Overall Performance ページを表示します。

関連情報

- プールの詳細は、アーキテクチャーガイド の プール を参照してください。

6.5. Ceph ファイルシステムの監視

ストレージ管理者は、Red Hat Ceph Storage Dashboard を使用して Ceph File Systems (CephFS) および関連するコンポーネントを監視することができます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスター

- Dashboard がインストールされている。

- Ceph File System がインストールされている。

手順

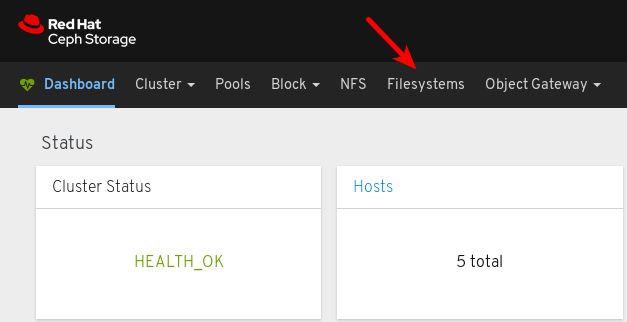

- ダッシュボードにログインします。

ナビゲーションバーで、Filesystems をクリックします。

以下の例では、cephfs ファイルシステムを確認できます。

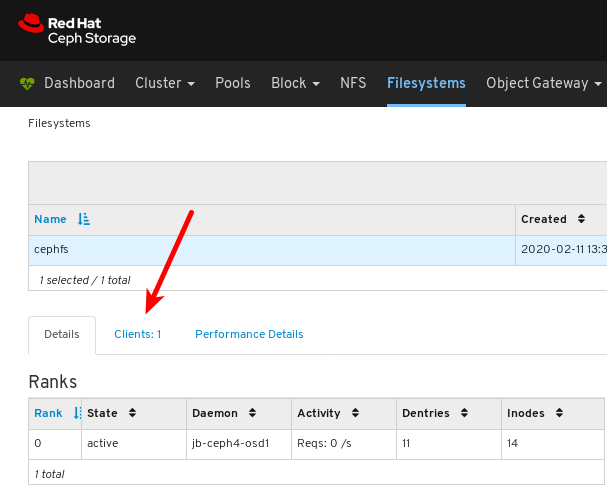

ファイルシステムの詳細を表示するには、cephfs の行をクリックします。

Details タブでは、メタデータサーバーとそのランクに加えて、スタンバイデーモン (1)、プールとその使用状況 (2)、パフォーマンスカウンター (3) を確認できます。

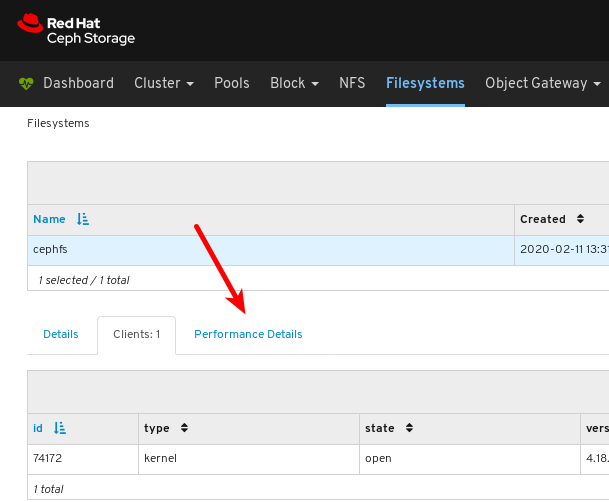

ファイルシステムをマウントしたクライアントの一覧を表示するには、Clients タブをクリックします。

以下の例では、

jb-ceph4-clientホストで cephfs ファイルシステムが開いていることがわかります。

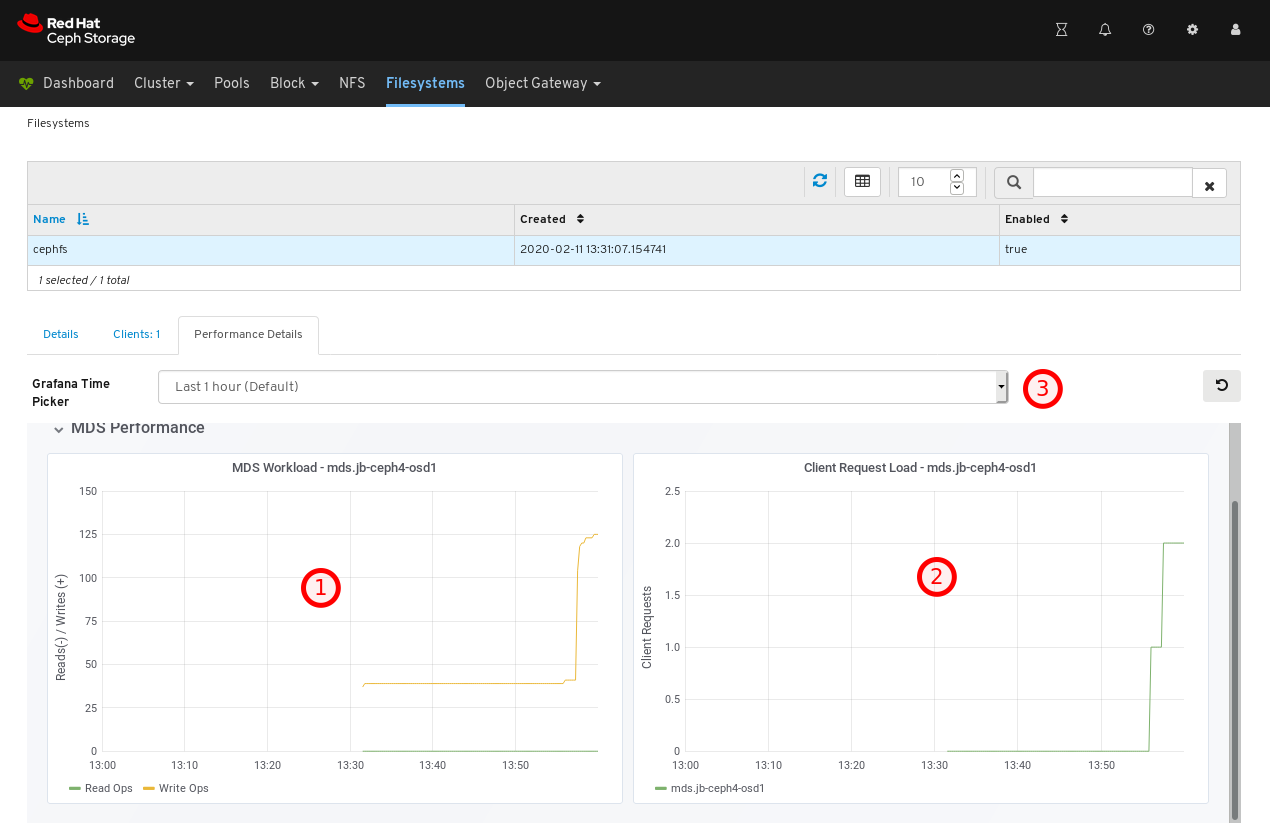

ファイルシステムのパフォーマンスを表示するには、Performance Details タブをクリックします。

以下の例では、読み取りおよび書き込み操作 (1)、クライアントリクエスト (2) で確認できます。時間の範囲は 3 で変更できます。

関連情報

- 詳細は、インストールガイド の メタデータサーバーのインストール を参照してください。

- 詳細は、ファイルシステムガイド を参照してください。

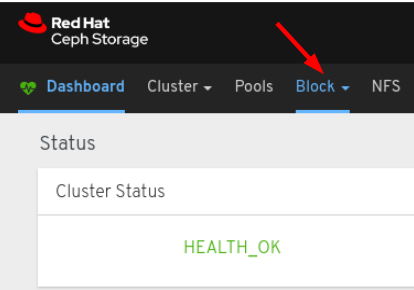

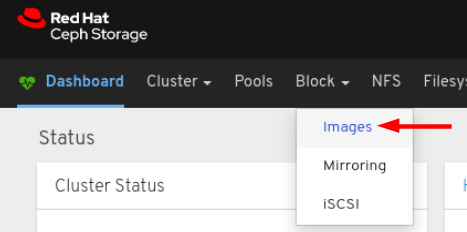

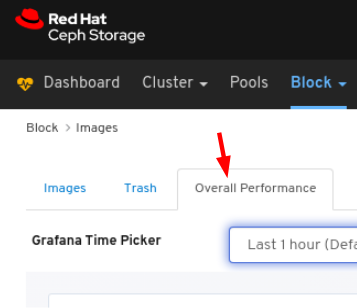

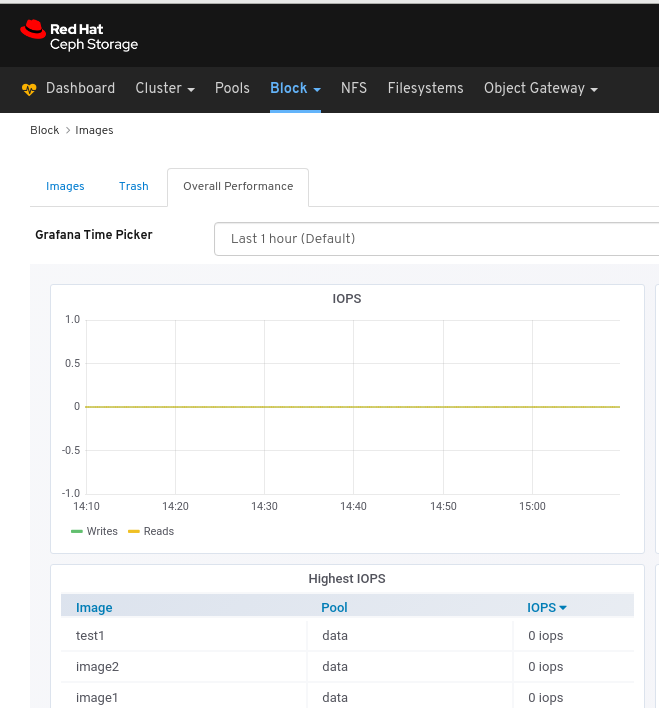

6.6. イメージの全パフォーマンスの監視

Red Hat Ceph Storage Dashboard により、Blocks 内のイメージの全体的なパフォーマンスを監視できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- RADOS Block Device (RBD) プールが作成されている。

- イメージが作成されている。

Manager モジュール Prometheus エクスポーターがプールに対して有効になります。

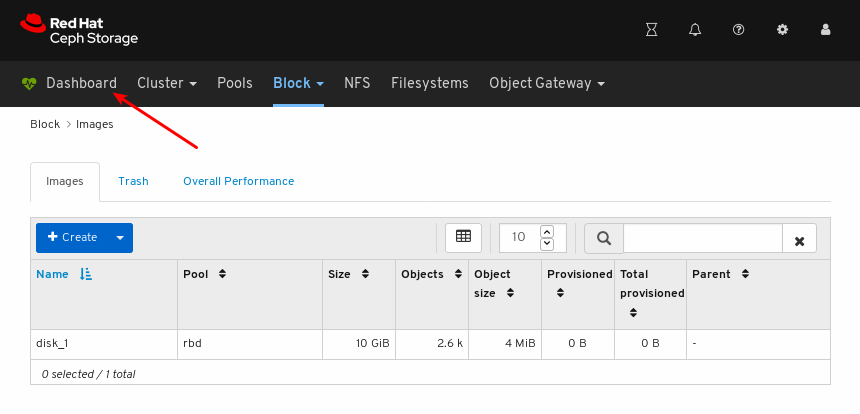

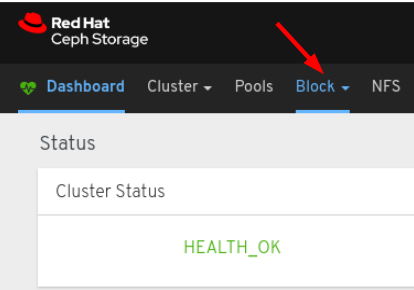

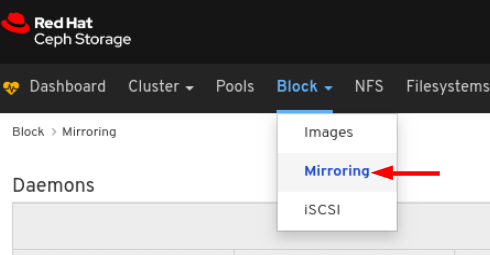

図6.1 例

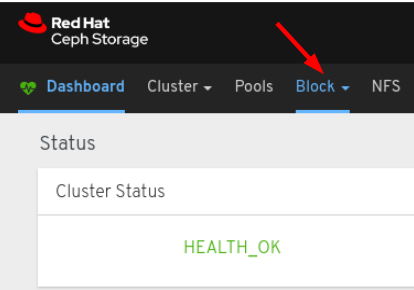

手順

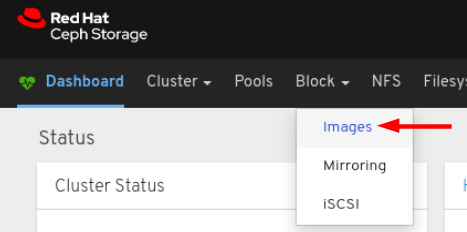

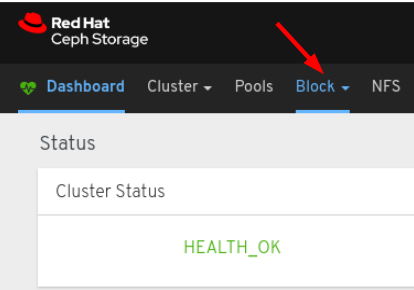

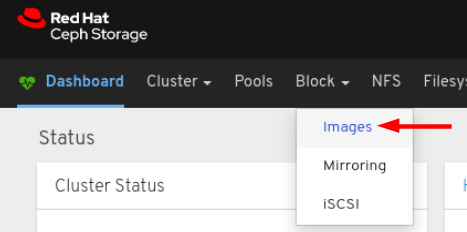

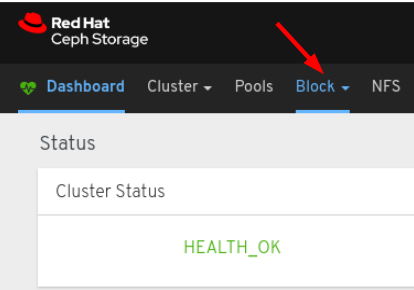

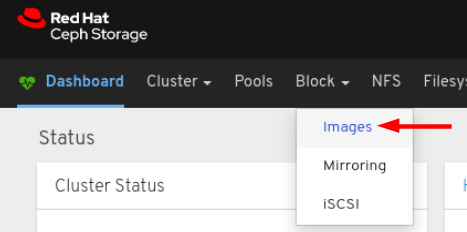

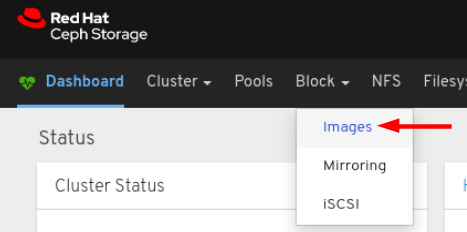

- ダッシュボードにログインします。

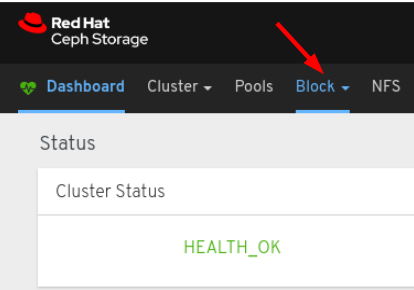

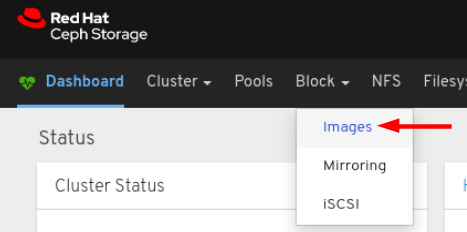

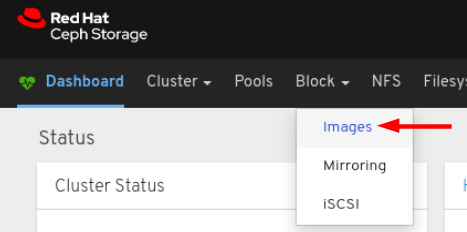

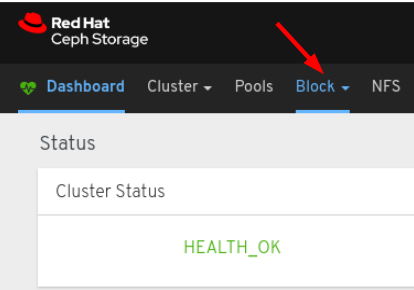

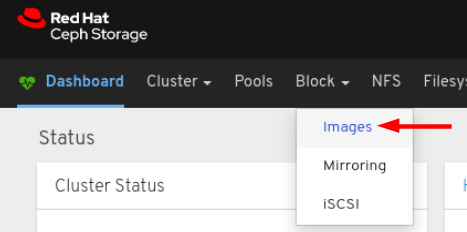

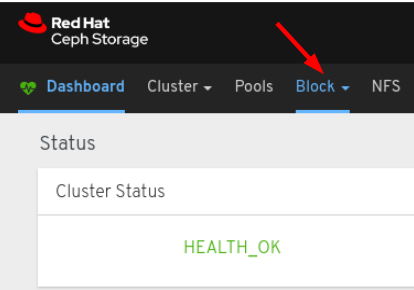

ナビゲーションバーで、Block をクリックします。

ドロップダウンから Images を選択します。

Overall Performance タブを選択します。

Grafana Time Picker ドロップダウンから時間の範囲を選択します。

Overall Performance ページを表示します。

第7章 クラスターの管理

7.1. クラスターの管理

ダッシュボードの管理機能により、設定設定を表示および変更し、クラスターリソースを管理することができます。

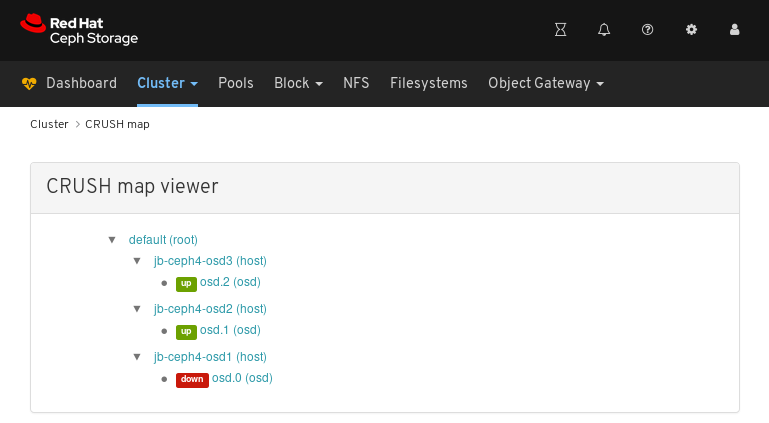

7.2. CRUSH マップの表示

CRUSH マップには、OSD および関連情報の一覧が含まれます。CRUSH マップおよび CRUSH アルゴリズムが一緒になって、データの保存方法と場所を決めます。Red Hat Ceph Storage ダッシュボードでは、OSD ホスト、OSD デーモン、ID 番号、デバイスクラスなど、CRUSH マップのさまざまな側面を確認することができます。

CRUSH マップを使用すると、特定の OSD ID が実行しているノードを決定できます。これは、OSD に問題がある場合に便利です。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

手順

- Dashboard にログインします。

- ナビゲーションバーで、Cluster をクリックします。

CRUSH map をクリックします。

上記の例では、デフォルトの CRUSH マップ、3 つのノード、および OSD が 3 つあるノードのうち 2 つで実行されているのを確認できます。

CRUSH マップ名、ノード、または OSD をクリックし、各オブジェクトの詳細を表示します。

上記の例では、

jb-rhel-osd3ノードで実行している OSD に関連する変数の値を確認できます。特に、idは2であることに注意してください。

関連情報

- CRUSH マップの詳細は、ストレージ戦略ガイド Storage strategies ガイド の CRUSH 管理 を参照してください。

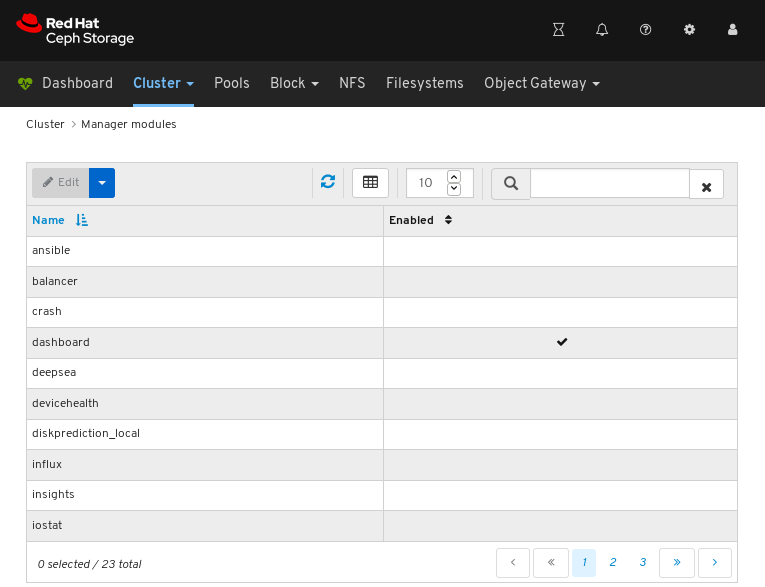

7.3. マネージャーモジュールの設定

Red Hat Ceph Storage ダッシュボードでは、マネージャーモジュールパラメーターの表示および設定を行うことができます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

手順

- Dashboard にログインします。

- ナビゲーションバーで、Cluster をクリックします。

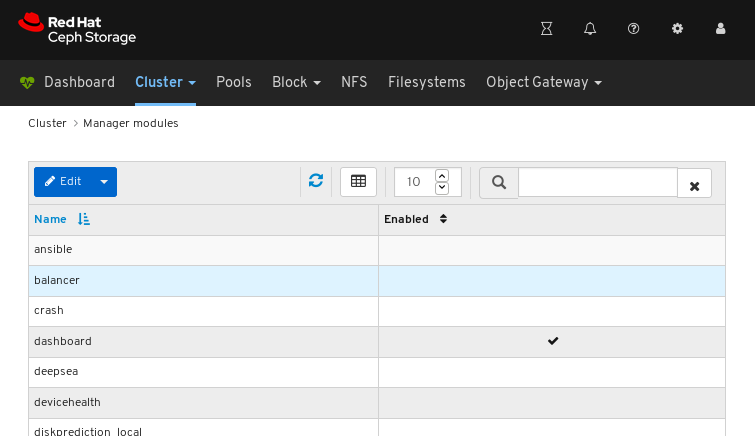

Manager モジュール をクリックします。

上記のスクリーンショットは、3 ページのマネージャーモジュールの最初のページを表示します。

設定するモジュールの行をクリックします。

すべてのモジュールに設定可能なパラメーターがあるわけではありません。モジュールが設定できない場合、Edit ボタンは無効になります。

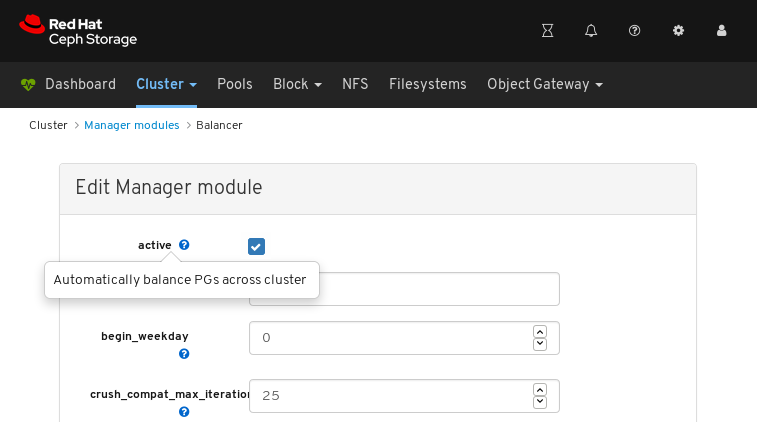

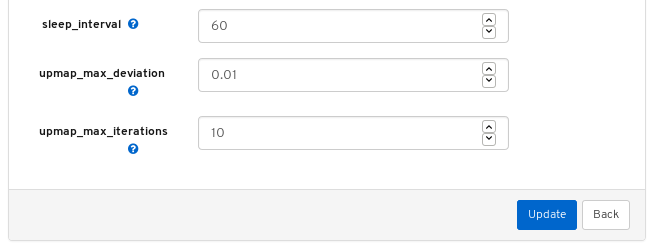

ページの左上にある Edit ボタンをクリックして、設定可能なパラメーターでページを読み込みます。

上記のスクリーンショットは、バランサーモジュールで変更できるパラメーターを示しています。パラメーターの説明を表示するには、クエスチョンマークボタンをクリックします。

パラメーターを変更するには、パラメーターの状態を変更し、ページ下部の Update ボタンをクリックします。

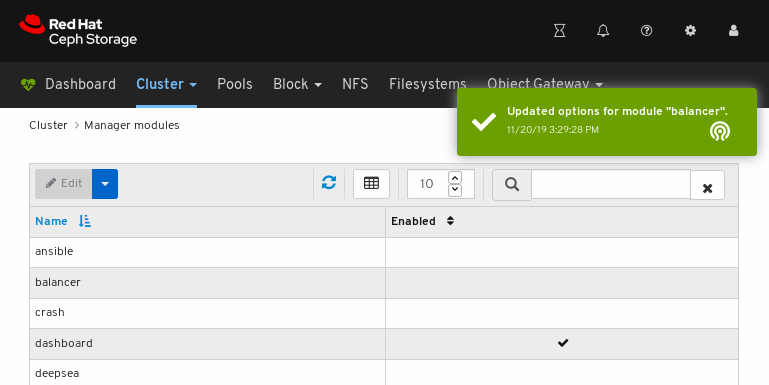

変更を確認する通知は、ページの右上隅に表示されます。

関連情報

- Red Hat Ceph Storage オペレーションガイドの Ceph Manager の balancer モジュールの使用 を参照してください。

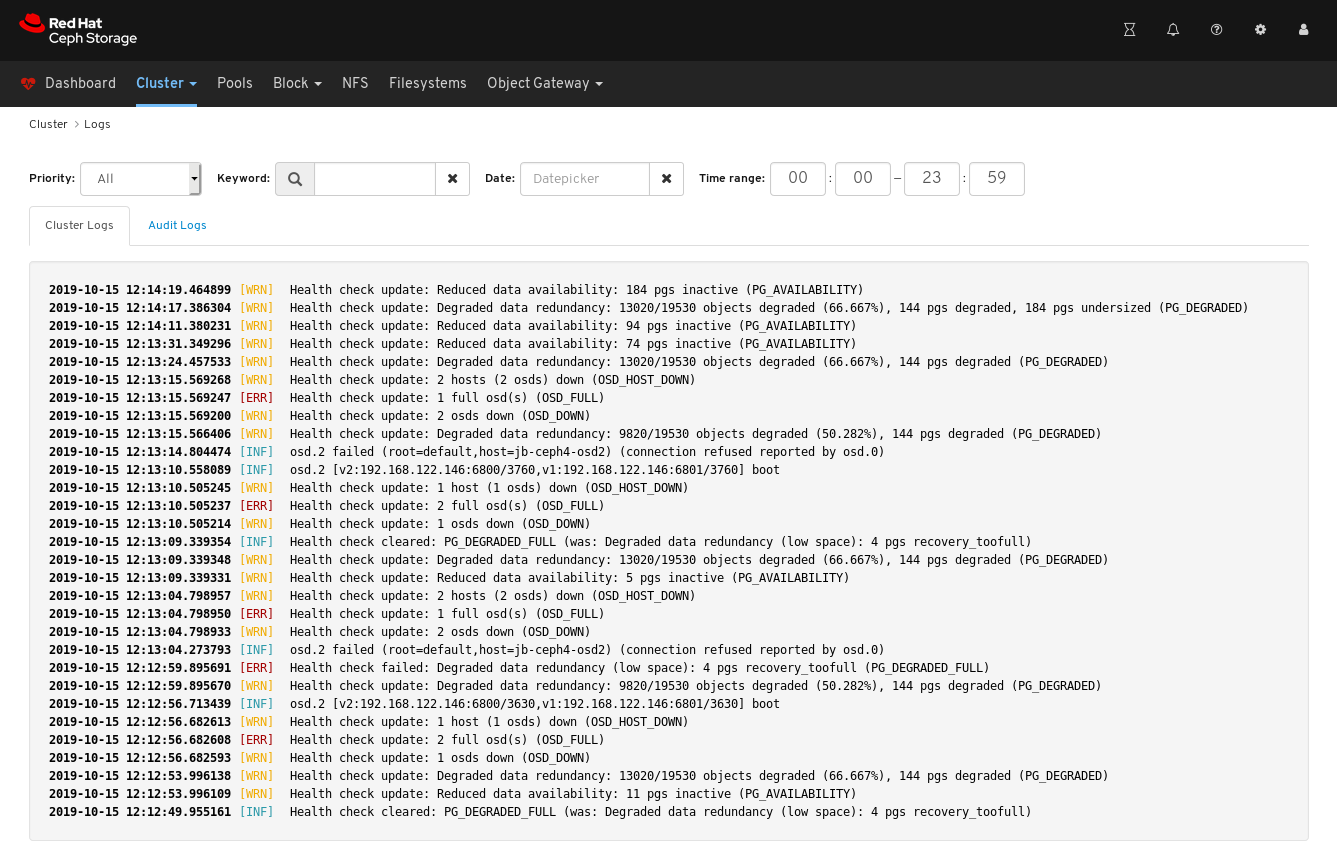

7.4. ログのフィルタリング

Red Hat Ceph Storage Dashboard では、複数の基準に基づくログの表示および絞り込みを行うことができます。条件には、優先度、キーワード、日付、および 時間の範囲 が含まれます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Monitor が最後に起動してからログエントリーが生成されている。

Dashboard ロギング機能は最新の高レベルイベントのみを表示します。イベントは Monitor によってメモリーに保存されます。Monitor を再起動すると、エントリーが消えます。詳細なログまたは古いログを確認する必要がある場合は、ファイルベースのログを参照してください。ファイルベースのログの詳細は、以下の関連情報を参照してください。

手順

- Dashboard にログインします。

-

上部ナビゲーションバーの

Clusterドロップダウンメニューをクリックします。 -

ドロップダウンメニューの

Logsをクリックします。 最後にフィルターが適用されていないログエントリーを表示します。

優先度で絞り込むには、

Priorityドロップダウンメニューをクリックし、Info、Warning、またはErrorのいずれかを選択します。以下の例は、Errorの優先度のログエントリーのみを示しています。

キーワードで絞り込むには、

Keywordフォームにテキストを入力します。以下の例は、osd.2というテキストが含まれるログエントリーのみを示しています。

日付で絞り込むには、

Dateフォームをクリックし、メニューから日付を選択するか、YYYY-MM-DD の形式で日付を入力します。以下の例は、2019-10-15のログエントリーのみを示しています。

時間で絞り込むには、HH:MM - HH:MM 形式を使用して

Time rangeフィールドに範囲を入力します。時間は、数字0から23に入力する必要があります。以下の例は、12:14から12:23へのログエントリーのみを示しています。

フィルターを組み合わせるには、2 つ以上のフィルターを設定します。以下の例は、

Warningの優先順位とosdのキーワードの両方を持つエントリーのみを示しています。

関連情報

- 詳細は、トラブルシューティングガイド の ロギングの設定 セクションを参照してください。

- 詳細は、トラブルシューティングガイド の トラブルシューティングガイド セクションを参照してください。

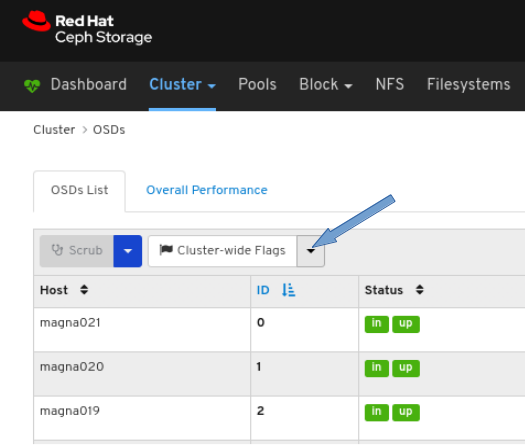

7.5. OSD リカバリー設定の設定

ストレージ管理者は、OSD リカバリーの優先度を変更し、クラスターの復旧方法をカスタマイズできます。これにより、クラスターの再ビルドのパフォーマンスまたはリカバリーの速度に影響を与える可能性もあります。

前提条件

- Red Hat Ceph Storage クラスター

- ダッシュボードがインストールされている。

手順

- ダッシュボードにログインします。

- 上部ナビゲーションバーの Cluster ドロップダウンメニューをクリックします。

- ドロップダウンメニューの OSD をクリックします。

Cluster-Wide flagss ドロップダウンメニューをクリックします。

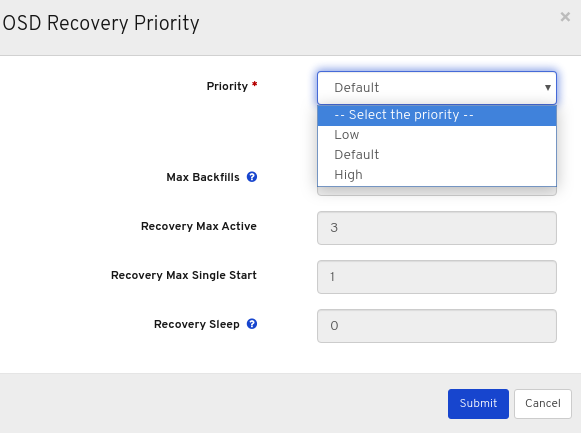

ドロップダウンで Cluster-wide Recovery Priority を選択します。

必要に応じて、ドロップダウンメニューで Priority を選択し、Submit ボタンをクリックします。

注記定義済みのオプションは、Low、Default、High の 3 つです。

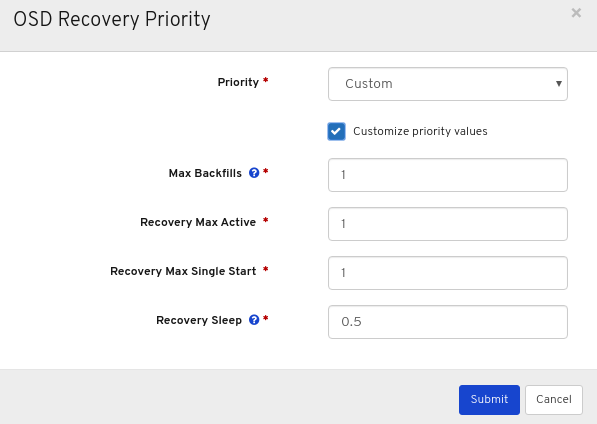

必要に応じて、Customize priority values をクリックして必要な変更を行い、Submit ボタンをクリックします。

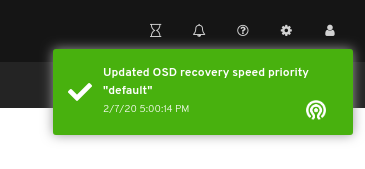

フラグが正常に更新されたことを示すポップアップの右上隅に対する通知。

関連情報

- OSD のリカバリーに関する詳細は、設定ガイドの OSD リカバリー を参照してください。

7.6. 設定の表示および監視

Red Hat Ceph Storage Dashboard では、Ceph クラスターの設定オプションの一覧を表示できます。Dashboard で設定を編集することもできます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

手順

- ダッシュボードにログインします。

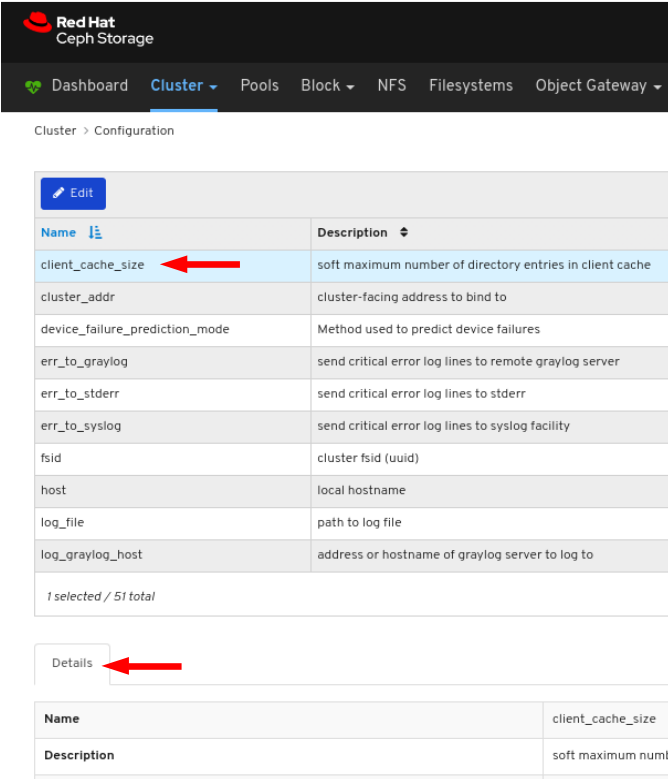

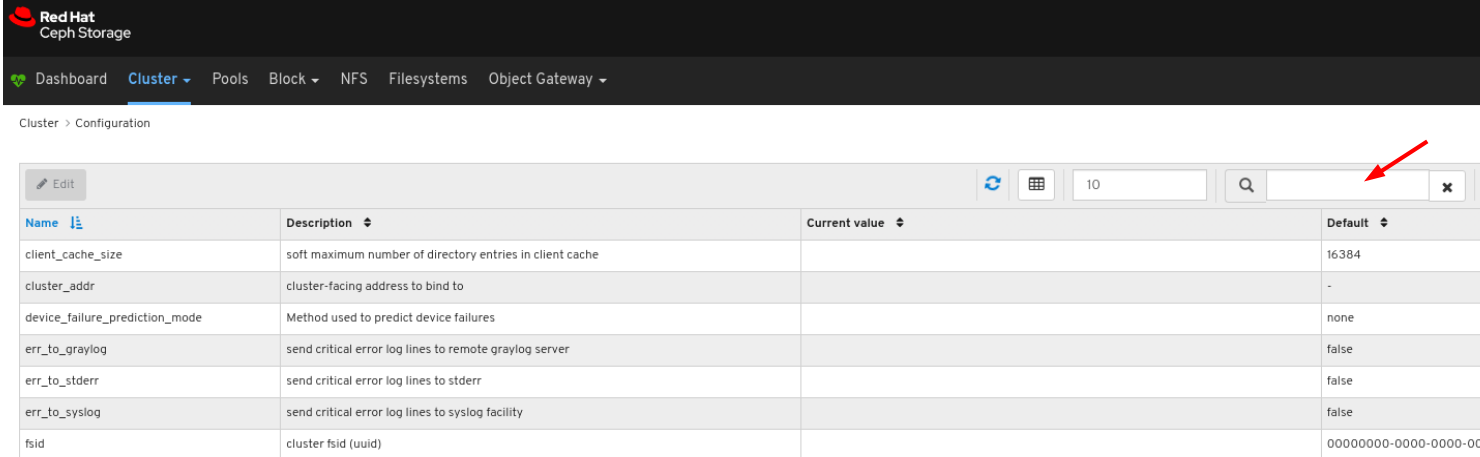

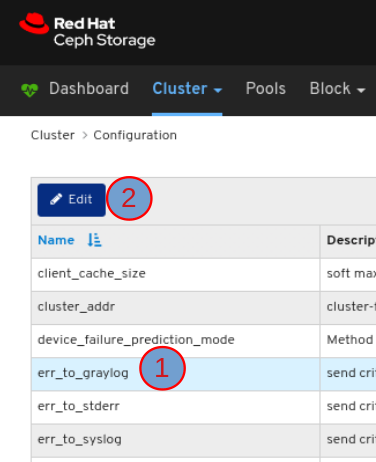

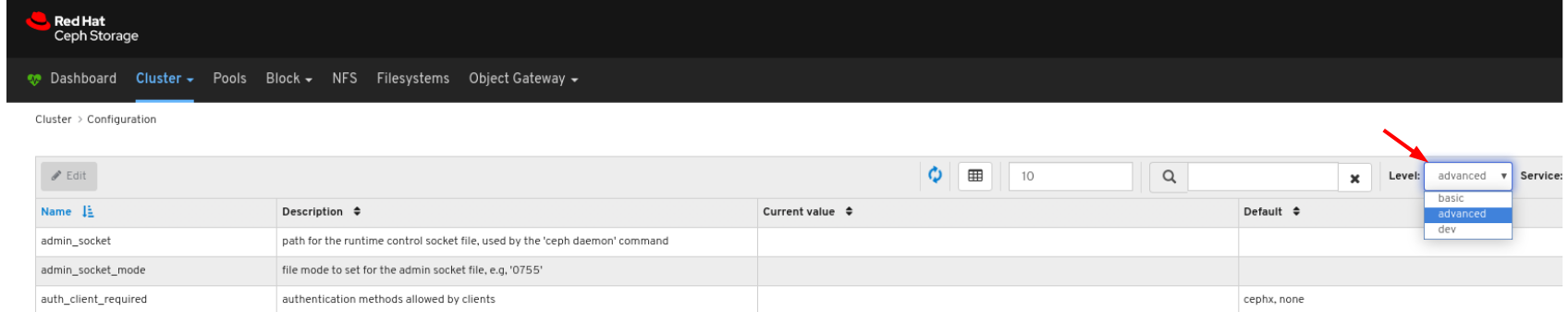

- ナビゲーションバーで Cluster をクリックした後、Configuration をクリックします。

設定の詳細を表示するには、その行をクリックします。

Search ボックスを使用して設定を検索できます。

Level、Service、または Source を使用して設定を絞り込むことができますのフィルターを設定できます。

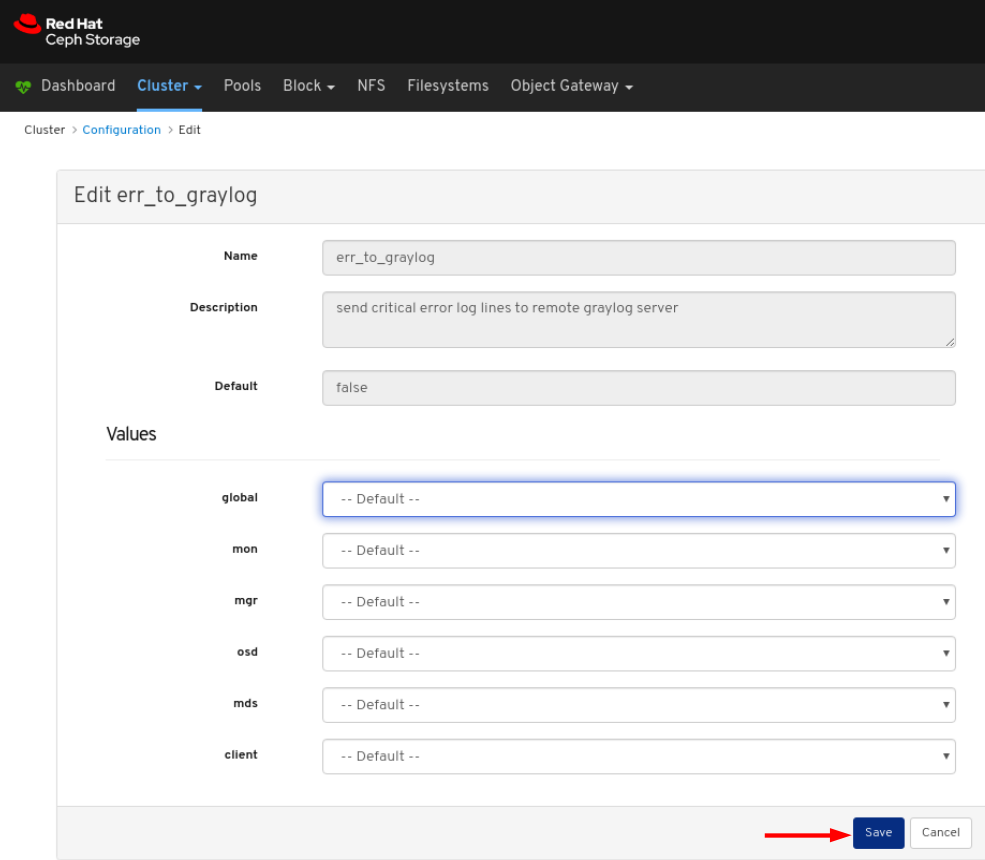

設定を編集するには、行をクリックして 編集 ボタンをクリックします。

ダイアログウィンドウで必要なパラメーターを編集し、Save ボタンをクリックします。

変更を確認する通知は、ページの右上隅に表示されます。

関連情報

- 詳細は、Red Hat Ceph Storage 設定ガイドの Ceph ネットワーク設定 の章を参照してください。

7.7. Prometheus 環境の管理

Prometheus を使用して Ceph ストレージクラスターを監視するには、Prometheus エクスポーターを設定および有効にし、Ceph ストレージクラスターに関するメタデータ情報を収集できるようにします。

前提条件

- 稼働中の Red Hat Ceph Storage 3.1 以降のクラスター。

- Red Hat Ceph Storage Dashboard インストール

- Red Hat Ceph Storage Dashboard ノードへのルートレベルのアクセス。

手順

/etc/prometheus/prometheus.ymlファイルを開いて編集します。globalセクションで、scrape_intervalおよびevaluation_intervalオプションを 15 秒に設定します。例

global: scrape_interval: 15s evaluation_interval: 15s

global: scrape_interval: 15s evaluation_interval: 15sCopy to Clipboard Copied! Toggle word wrap Toggle overflow scrape_configsセクションの下にhonor_labels: trueオプションを追加し、ceph-mgrノードごとにtargetsオプションおよびinstanceオプションを編集します。例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記honor_labelsオプションを使用すると、Ceph は Ceph Storage クラスターの任意のノードに関連する適切にラベル付けされたデータを出力できます。これにより、Prometheus が上書きせずに Ceph は適切なinstanceラベルをエクスポートできます。新規ノードを追加するには、以下の形式で

targetsオプションおよびinstanceオプションを追加します。例

- targets: [ 'new-node.example.com:9100' ] labels: instance: "new-node"- targets: [ 'new-node.example.com:9100' ] labels: instance: "new-node"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記instanceラベルは、Ceph の OSD メタデータのinstanceフィールドに表示されるノードの短いホスト名と一致する必要があります。これにより、Ceph 統計をノードの統計と関連付けるのに役立ちます。

以下の形式で、Ceph ターゲットを

/etc/prometheus/ceph_targets.ymlファイルに追加します。例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Prometheus モジュールを有効にします。

ceph mgr module enable prometheus

[root@mon ~]# ceph mgr module enable prometheusCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8. grafana-server と Prometheus の復元

grafana-server には、Grafana UI、Prometheus、コンテナー、および Red Hat Ceph Storage 設定が含まれています。grafana-server がクラッシュまたは故障した場合、ファイルのバックアップを取り、バックアップされたファイルを使用して復元することで復元できます。Prometheus の場合、外部バックアップを作成してからデータを復元できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Grafana ノードへのルートレベルのアクセス。

手順

Grafana データベースのバックアップを取ります。

grafana-server ノードで、Grafana サービスを停止します。

例

systemctl stop grafana-server.service systemctl status grafana-server.service

[root@node04 ~]# systemctl stop grafana-server.service [root@node04 ~]# systemctl status grafana-server.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow Grafana データベースのバックアップを取ります。

例

cp /var/lib/grafana/grafana.db /var/lib/grafana/grafana_backup.db

[root@node04 ~]# cp /var/lib/grafana/grafana.db /var/lib/grafana/grafana_backup.dbCopy to Clipboard Copied! Toggle word wrap Toggle overflow grafana-server ノードで、Grafana サービスを再起動します。

例

systemctl restart grafana-server.service

[root@node04 ~]# systemctl restart grafana-server.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

grafana サーバーを復元します。

grafana-server ノードで、Grafana サービスが実行されている場合は、サービスを停止します。

例

systemctl stop grafana-server.service systemctl status grafana-server.service

[root@node04 ~]# systemctl stop grafana-server.service [root@node04 ~]# systemctl status grafana-server.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow バックアップした

grafana.dbファイルを/var/lib/grafana/ディレクトリーに移動します。例

mv /var/lib/grafana/grafana_backup.db /var/lib/grafana/

[root@node04 ~]# mv /var/lib/grafana/grafana_backup.db /var/lib/grafana/Copy to Clipboard Copied! Toggle word wrap Toggle overflow grafana-server ノードで、Grafana サービスを再起動します。

例

systemctl restart grafana-server.service

[root@node04 ~]# systemctl restart grafana-server.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Prometheus アラートの場合、

prometheus_data_dirディレクトリー (デフォルトではvar/lib/prometheusディレクトリー である Ceph-Ansible 設定) の外部バックアップを取得し、バックアップされたディレクトリーを使用してサービスを復元する必要があります。grafana-server ノードで、Prometheus サービスを停止します。

例

systemctl stop prometheus.service systemctl status prometheus.service

[root@node04 ~]# systemctl stop prometheus.service [root@node04 ~]# systemctl status prometheus.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow デフォルトの Prometheus ディレクトリーのバックアップを取得します。

例

cp /var/lib/prometheus/ /var/lib/prometheus_backup/

[root@node04 ~]# cp /var/lib/prometheus/ /var/lib/prometheus_backup/Copy to Clipboard Copied! Toggle word wrap Toggle overflow prometheus_data_dirディレクトリーをバックアップしたディレクトリーに置き換えます。例

mv /var/lib/prometheus_backup/ /var/lib/prometheus_data_dir

[root@node04 ~]# mv /var/lib/prometheus_backup/ /var/lib/prometheus_data_dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow grafana-server ノードで、prometheus サービスを再起動します。

例

systemctl restart prometheus.service systemctl status prometheus.service

[root@node04 ~]# systemctl restart prometheus.service [root@node04 ~]# systemctl status prometheus.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記group_vars/all.ymlファイルで Prometheus パラメーターを変更した場合は、プレイブックを再実行する必要があります。

オプション: 変更が Red Hat Ceph Storage ダッシュボードに反映されない場合は、ダッシュボードを無効にしてから有効にする必要があります。

例

ceph mgr module disable dashboard ceph mgr module enable dashboard

[root@node04 ~]# ceph mgr module disable dashboard [root@node04 ~]# ceph mgr module enable dashboardCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.9. アラートの表示および管理

ストレージ管理者は、Red Hat Ceph Storage Dashbaoard でアラートの詳細を表示し、アラートのサイレンスを作成できます。これには、次の事前定義されたアラートが含まれます。

- OSD(s) Down

- Ceph Health Error

- Ceph Health Warning

- Cluster Capacity Low

- Disk(s) Near Full

- MON(s) Down

- Network Errors

- OSD Host Loss Check

- OSD Host(s) Down

- OSD(s) with High PG Count

- PG(s) Stuck

- Pool Capacity Low

- Slow OSD Responses

7.9.1. アラートの表示

アラートが起動したら、Red Hat Ceph Storage Dashboard でアラートを表示できます。ダッシュボードを有効にして、アラートに関するメールを送信することもできます。

Simple mail transfer protocol (SMTP) および SSL は、Red Hat Ceph Storage 4 クラスターではサポートされていません。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- アラートが発生している。

手順

- ダッシュボードにログインします。

ダッシュボードの alerts モジュールをカスタマイズして、ストレージクラスターの電子メールアラートを取得します。

- ナビゲーションバーで、Cluster をクリックします。

- Manager modules を選択します。

- アラート モジュールを選択します。

- Edit ドロップダウンメニューで、Edit を選択します。

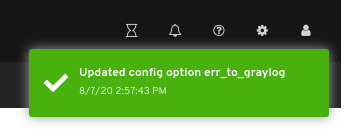

Edit Manager module で、必要なパラメーターを更新し、Update をクリックします。

図7.1 アラートの Manager モジュールの編集

- ナビゲーションバーで、Cluster をクリックします。

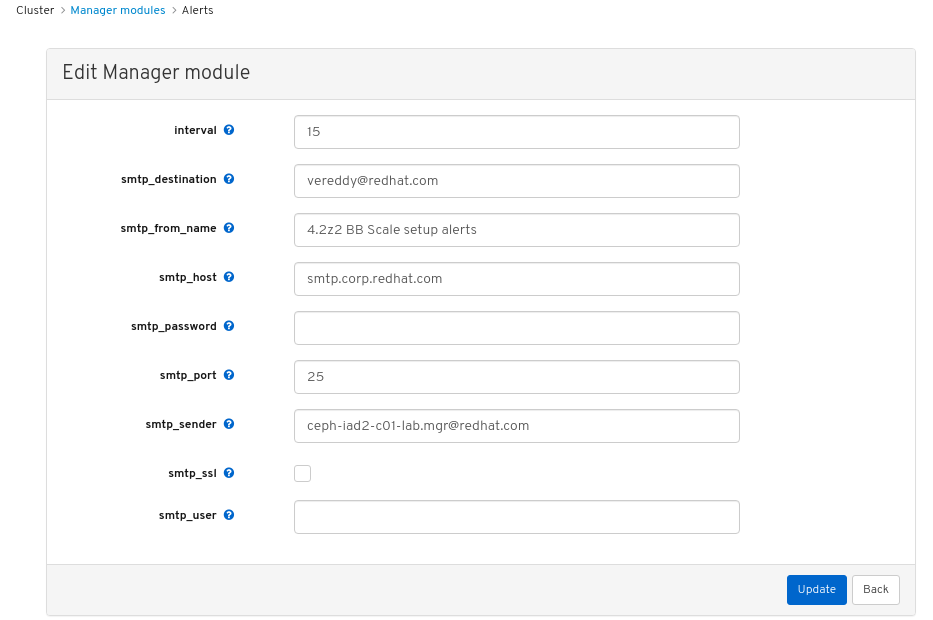

- ドロップダウンメニューから Monitoring を選択します。

アラートの詳細を表示するには、その行をクリックします。

図7.2 アラートの詳細

- アラートのソースを表示するには、その行をクリックし、Source をクリックします。

7.9.2. サイレンスの作成

Red Hat Ceph Storage Dashboard で、アラートを一定期間サイレントに作成できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- アラートが発生している。

手順

- Dashboard にログインします。

- ナビゲーションバーで、Cluster をクリックします。

- ドロップダウンメニューから Monitoring を選択します。

- アラートの行をクリックし、+Create Silence をクリックします。

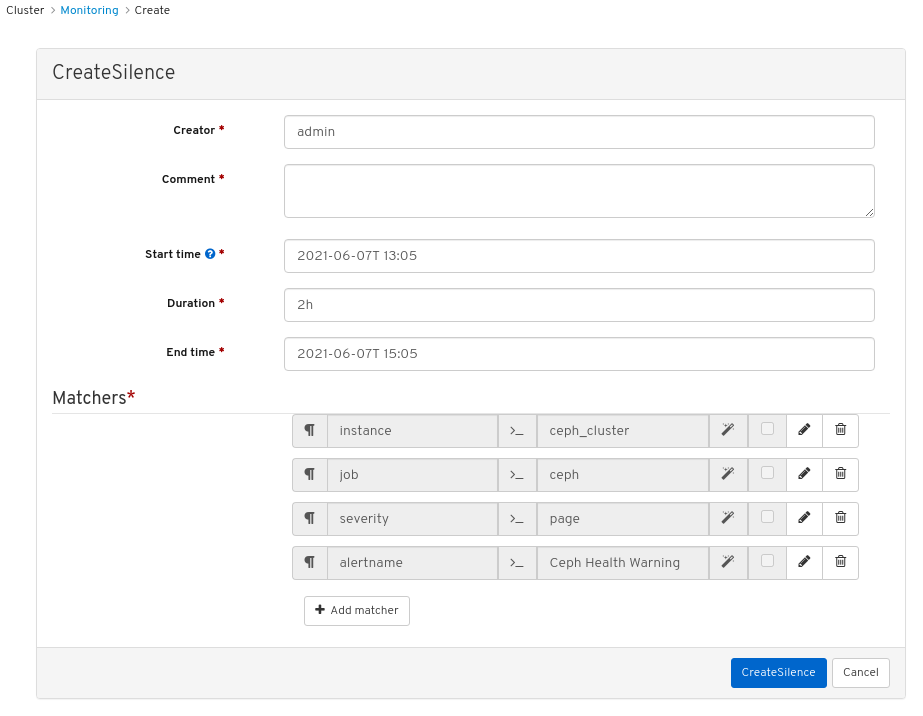

Create Silence ウィンドウで、Duration の詳細を追加し、Create Silence をクリックします。

図7.3 サイレンスの作成

- サイレンスが正常に作成されたという通知が表示されます。

7.9.3. サイレンスの再作成

Red Hat Ceph Storage Dashboard で、期限切れのサイレンスをもとにサイレンスを再作成できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- アラートが発生している。

- アラートのサイレンスが作成されている。

手順

- ダッシュボードにログインします。

- ドロップダウンメニューから Monitoring を選択します。

- Silences タブをクリックします。

- 期限切れの Silence の行をクリックします。

- Recreate ボタンをクリックします。

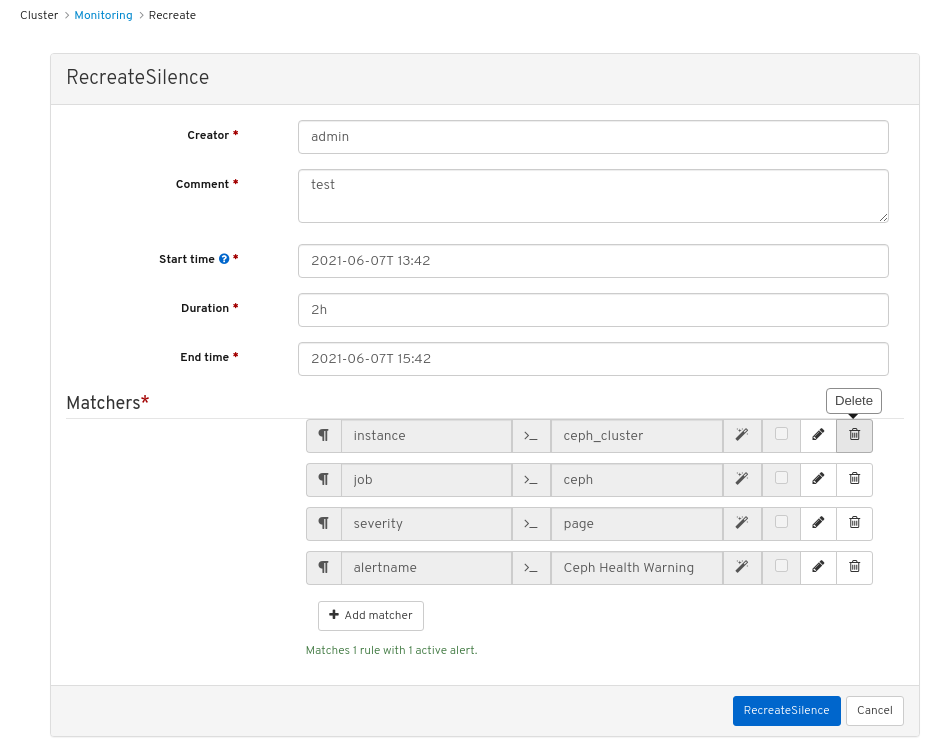

RecreateSilence ウィンドウで詳細を追加し、RecreateSilence をクリックします。

図7.4 サイレンスの再作成

- サイレンスが正常に再作成されたという通知が表示されます。

7.9.4. サイレンスの編集

アクティブなサイレンスは、Red Hat Ceph Storage Dashboard でアクティブな時間を延長するなど、編集が可能です。サイレンスの有効期限が切れている場合は、サイレンスを再作成するか、アラート用に新しいサイレンスを作成することができます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- アラートが発生している。

- アラートのサイレンスが作成されている。

手順

- Dashboard にログインします。

- ナビゲーションバーで、Cluster をクリックします。

- ドロップダウンメニューから Monitoring を選択します。

- Silences タブをクリックします。

- Silence の行をクリックします。

- Edit ドロップダウンメニューで、Edit を選択します。

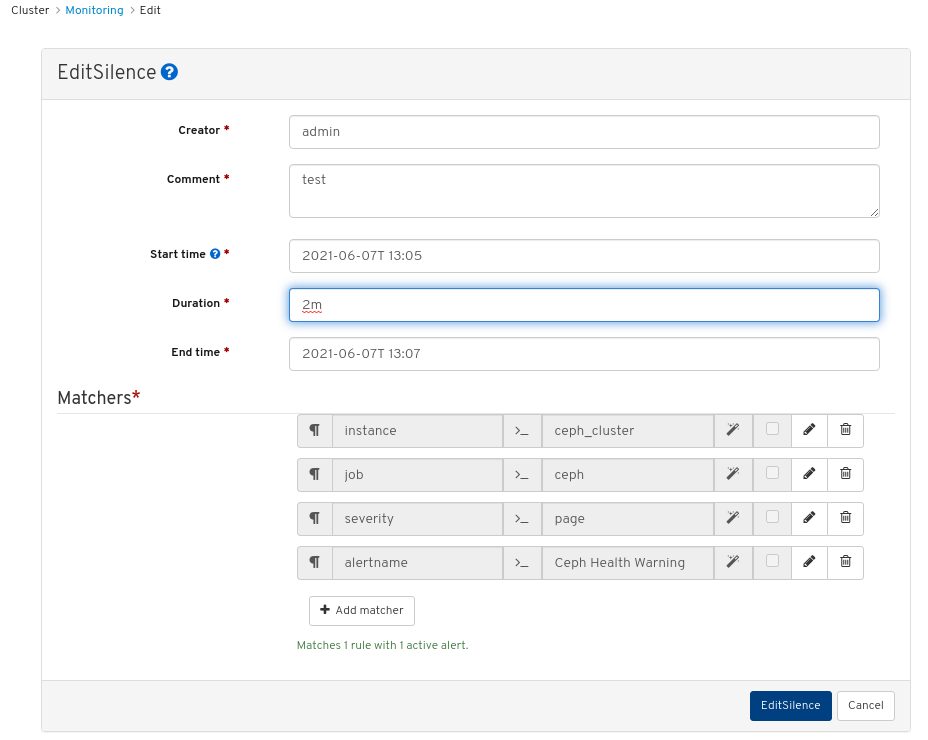

EditSilence ウィンドウで詳細を更新し、Edit Silence をクリックします。

図7.5 サイレンスの編集

- サイレンスが正常に更新されたという通知が表示されます。

7.9.5. サイレンスの終了

Red Hat Ceph Storage Dashbaoard で一致したアラートが抑制されないように、サイレンスを期限切れにすることができます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- アラートが発生している。

- アラートのサイレンスが作成されている。

手順

- Dashboard にログインします。

- ナビゲーションバーで、Cluster をクリックします。

- ドロップダウンメニューから Monitoring を選択します。

- Silences タブをクリックします。

- Silence の行をクリックします。

- Edit ドロップダウンメニューで、Expire を選択します。

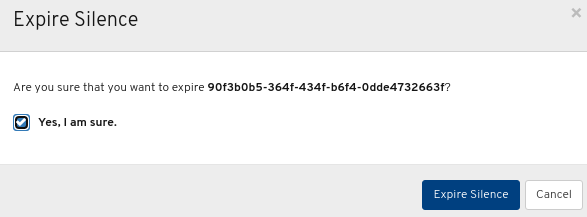

Expire Silence ダイアログボックスで、Yes, I am sure を選択し、Expire Silence をクリックします。

図7.6 サイレンスの期限切れ

- サイレンスが正常に失効したという通知が届きます。

7.10. プールの管理

ストレージ管理者は、プールを作成、削除、および編集できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスター

- Dashboard がインストールされている。

7.10.1. プールの作成

プールを作成して、ストレージオブジェクトを論理的にパーティション分割できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

手順

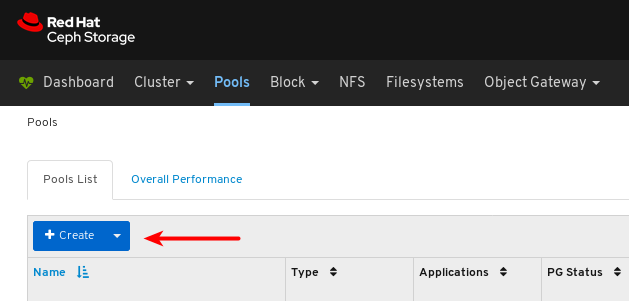

- ダッシュボードにログインします。

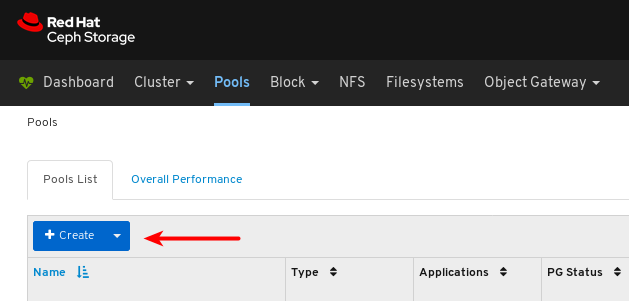

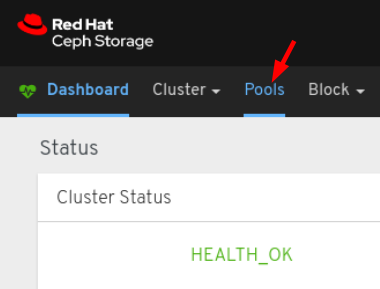

ナビゲーションバーで、Pools をクリックします。

ページの左上隅にある Create ボタンをクリックします。

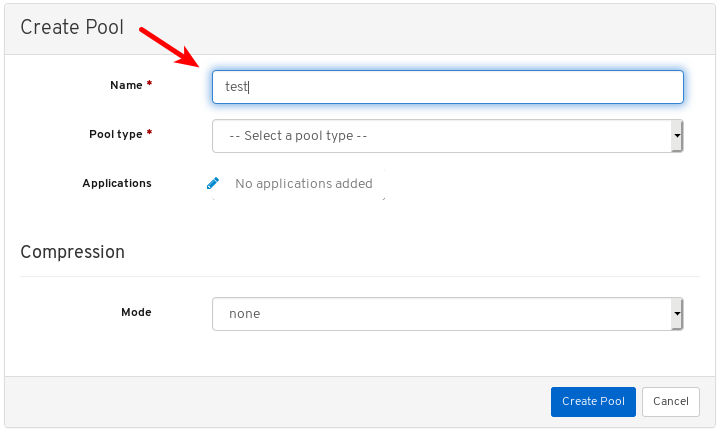

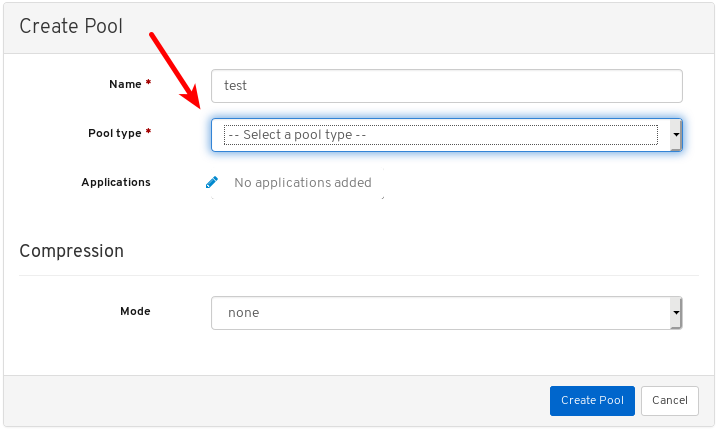

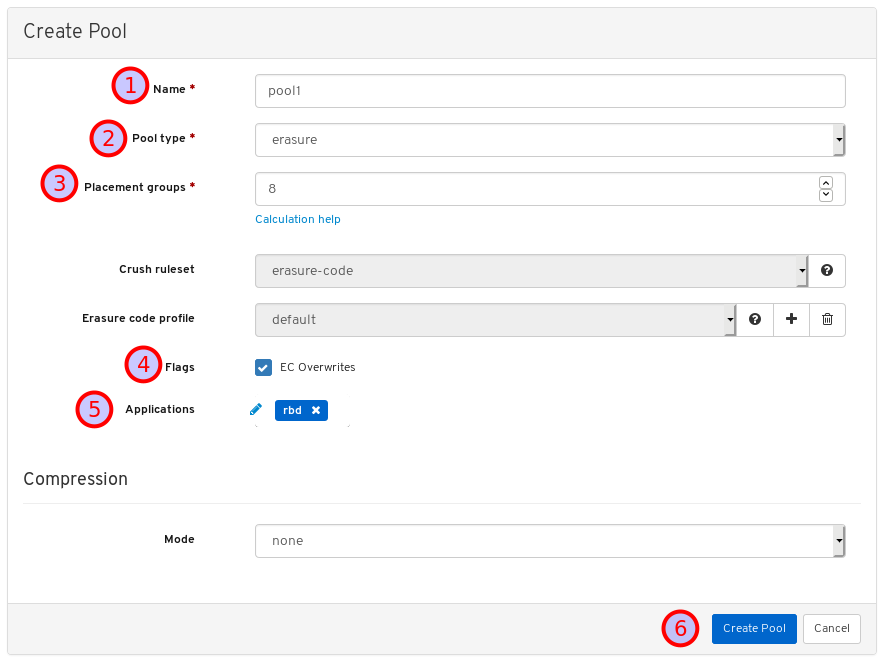

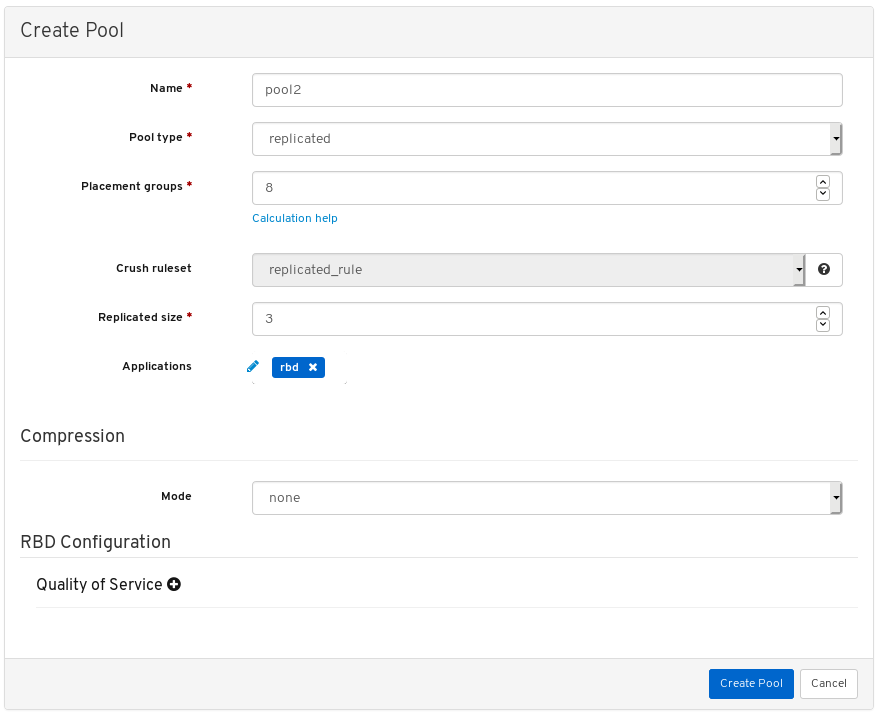

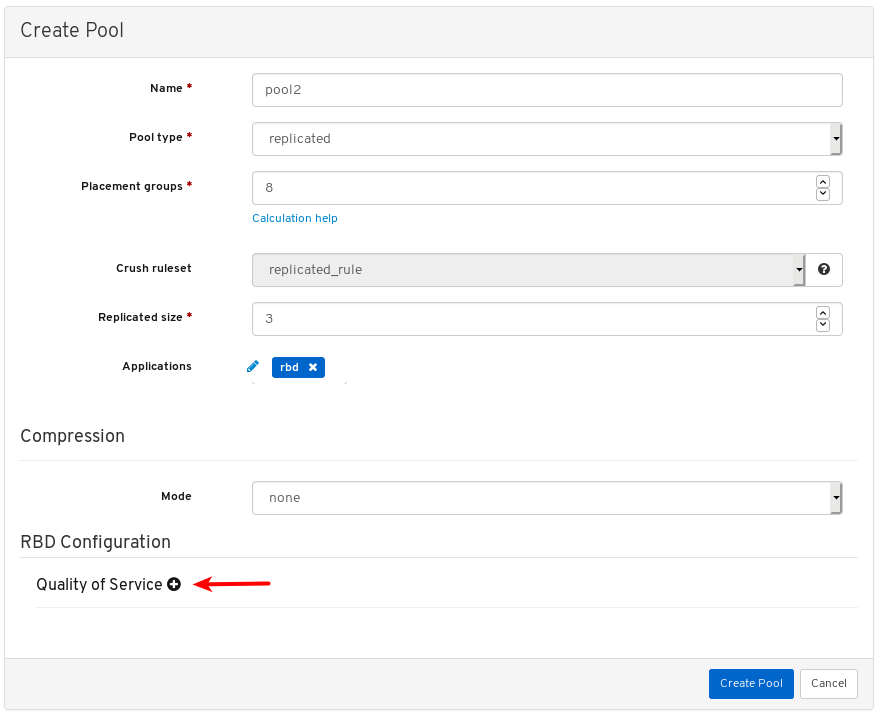

ダイアログウィンドウで、名前を設定します。

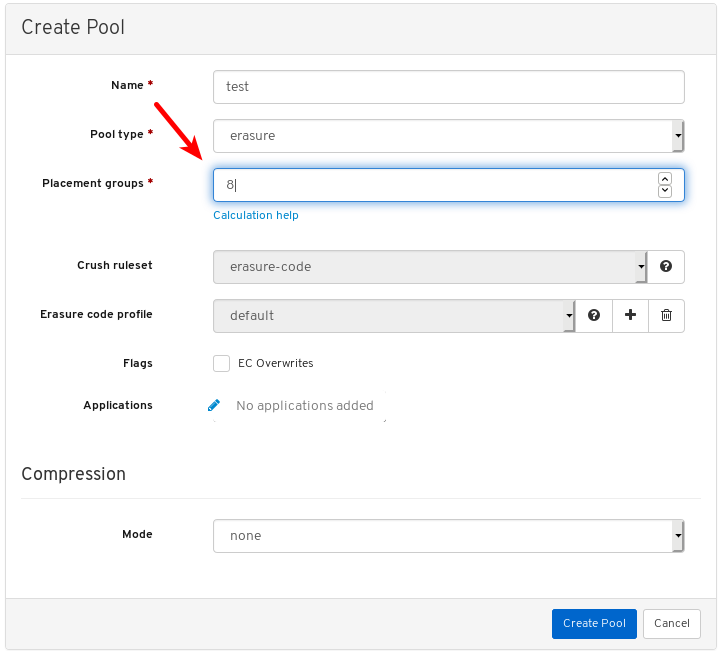

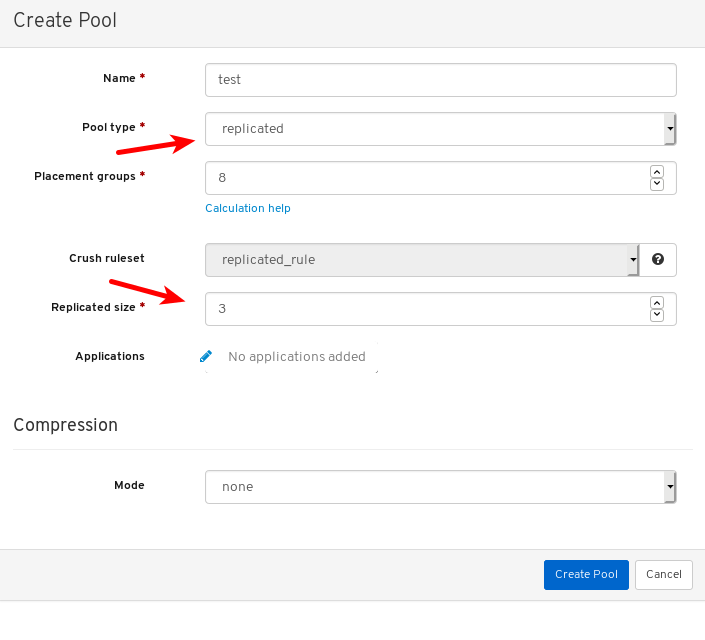

レプリケートまたはイレイジャーコード (EC) のいずれかのプールタイプを選択します。

配置グループ (PG) 番号を設定します。

PG 番号の選択には、PG calculator を使用します。不明な場合は、Red Hat テクニカルサポート にお問い合わせください。

必要に応じて、レプリケートされたプールタイプを使用する場合は、レプリケートされたサイズを設定します。

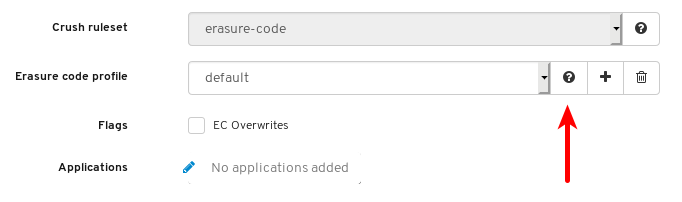

必要に応じて、EC プールタイプを使用する場合には、以下の追加設定を設定します。

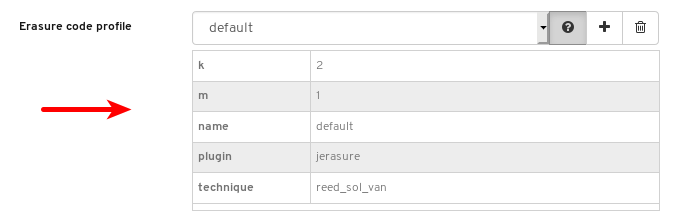

必要に応じて、現在選択されている EC プロファイルの設定を確認するには、クレスチョンマークをクリックします。

選択した EC プロファイルの設定の表が表示されます。

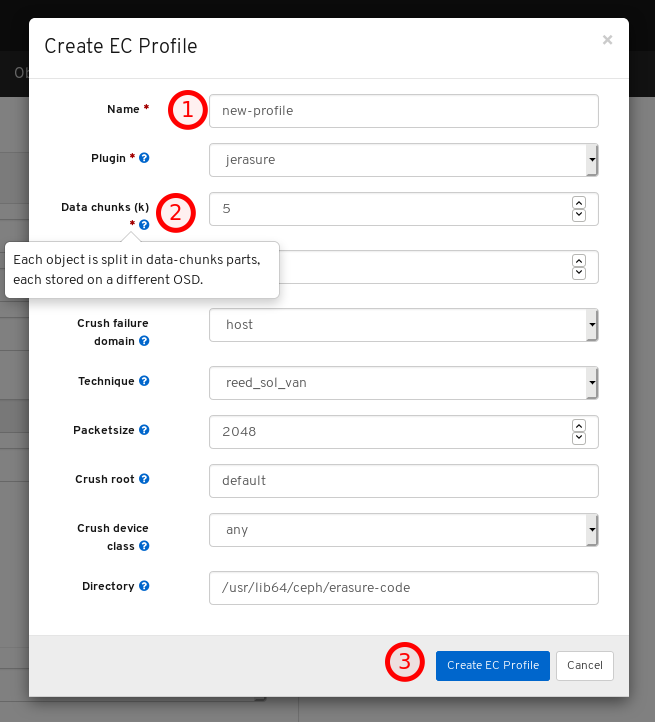

必要に応じて、プラス記号をクリックして、新しい EC プロファイルを追加します。

新しい EC プロファイルの名前を設定 (1) し、その設定に関する情報のクエスチョンマークをクリック (2) して、必要な設定をすべて変更したら Create EC Profile をクリック (3) します。

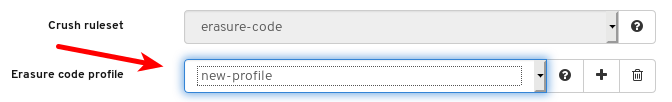

新しい EC プロファイルを選択します。

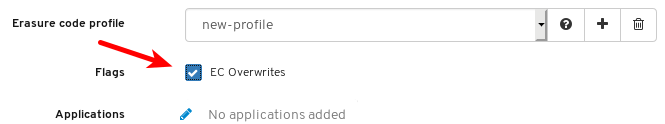

必要に応じて、EC の上書きが必要な場合は、そのボタンをクリックします。

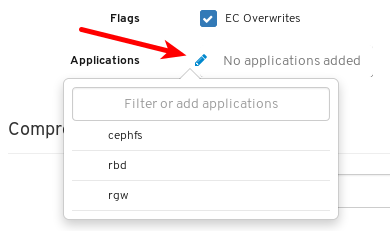

必要に応じて、鉛筆記号をクリックして、プールのアプリケーションを選択します。

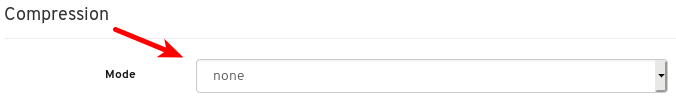

必要に応じて、圧縮が必要な場合は、passive、aggressive、または force を選択します。

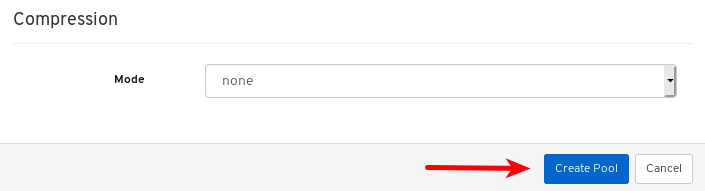

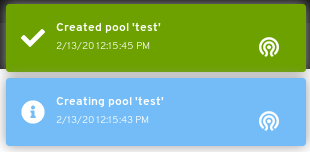

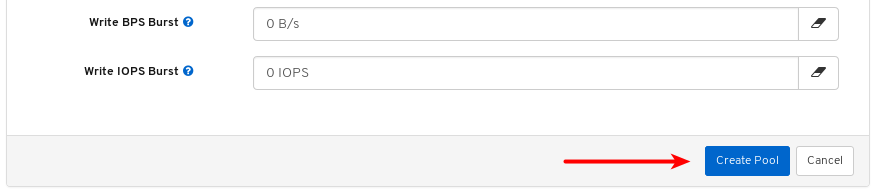

Create Pool ボタンをクリックします。

ページの右上隅に対する通知は、プールが正常に作成されたことを示しています。

関連情報

- 詳しくは、アーキテクチャーガイド の Ceph プール を参照してください。

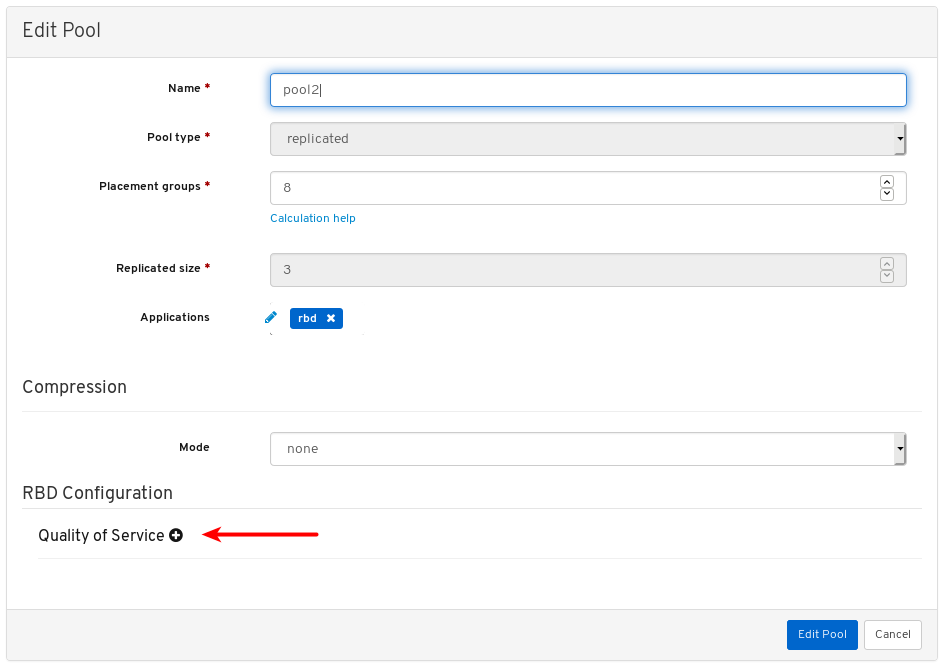

7.10.2. プールの編集

Red Hat Ceph Storage Dashboard では、プールの編集が可能です。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- プールが作成されている。

手順

- ダッシュボードにログインします。

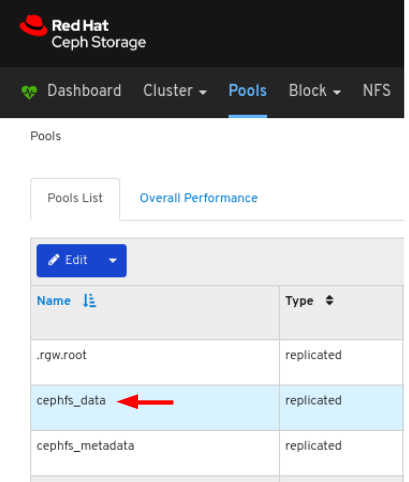

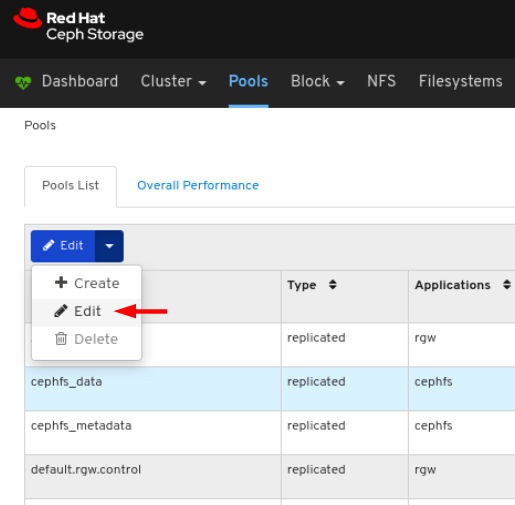

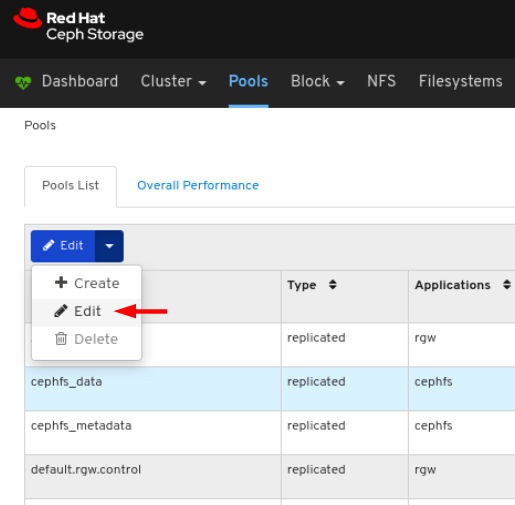

ナビゲーションバーで、Pools をクリックします。

プールを編集するには、その行をクリックします。

Edit ドロップダウンメニューで Edit を選択します。

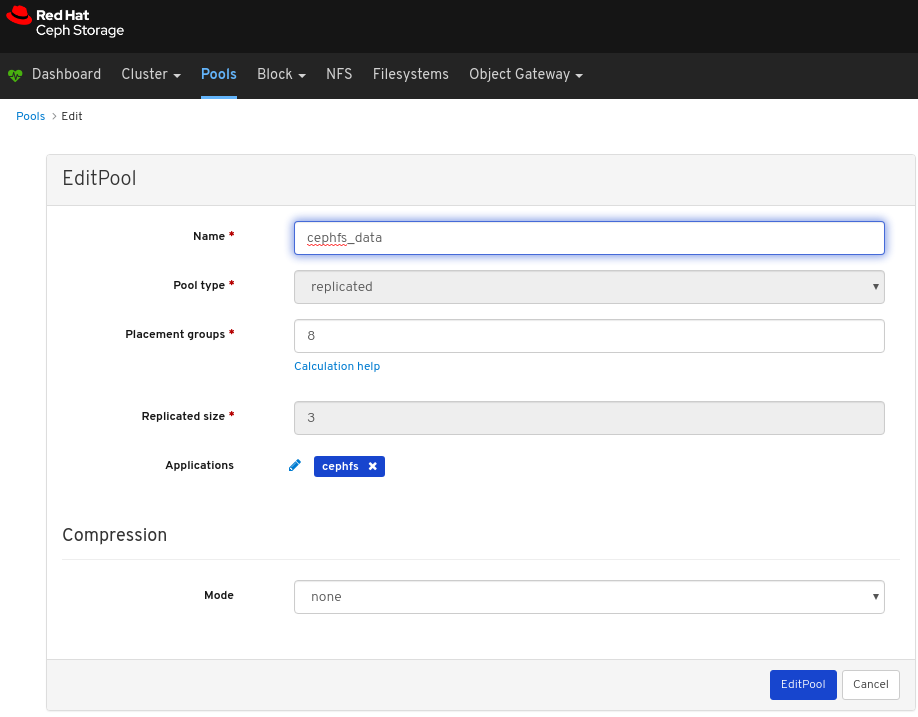

ダイアログウィンドウで必要なパラメーターを編集し、EditPool ボタンをクリックします。

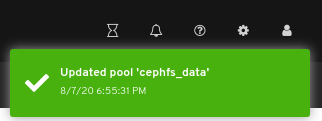

ページの右上隅に対する通知は、プールが正常に更新されたことを示します。

7.10.3. プールの削除

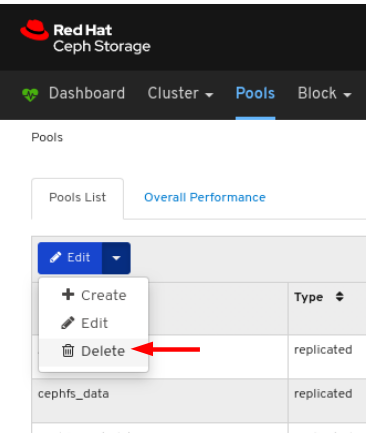

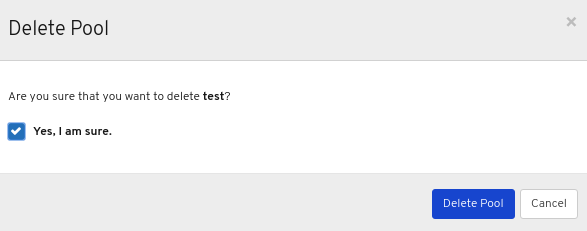

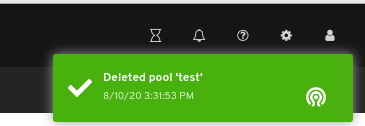

Red Hat Ceph Storage Dashboard ではプールの削除が可能です。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- プールが作成されている。

手順

- ダッシュボードにログインします。

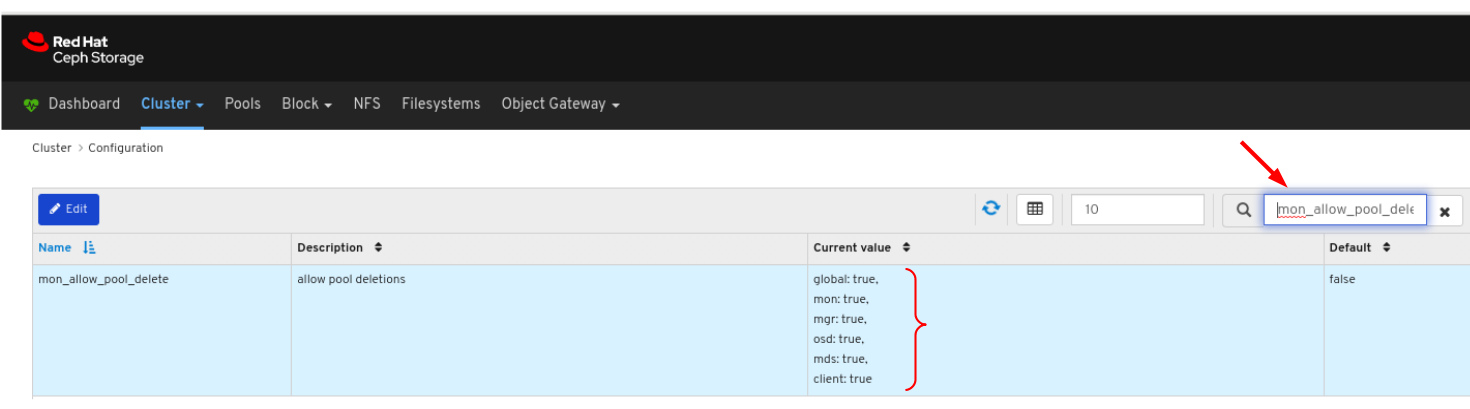

mon_allow_pool_deleteの値がtrueに設定されていることを確認します。- ナビゲーションバーで Cluster をクリックした後、Configuration をクリックします。

Level ドロップダウンメニューで、Advanced を選択します。

mon_allow_pool_deleteを検索し、値をtrueに設定します。

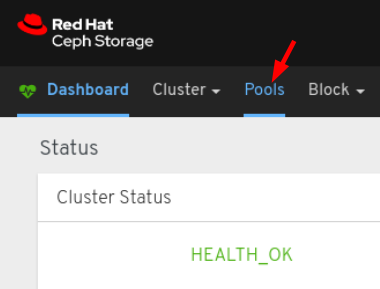

ナビゲーションバーで、Pools をクリックします。

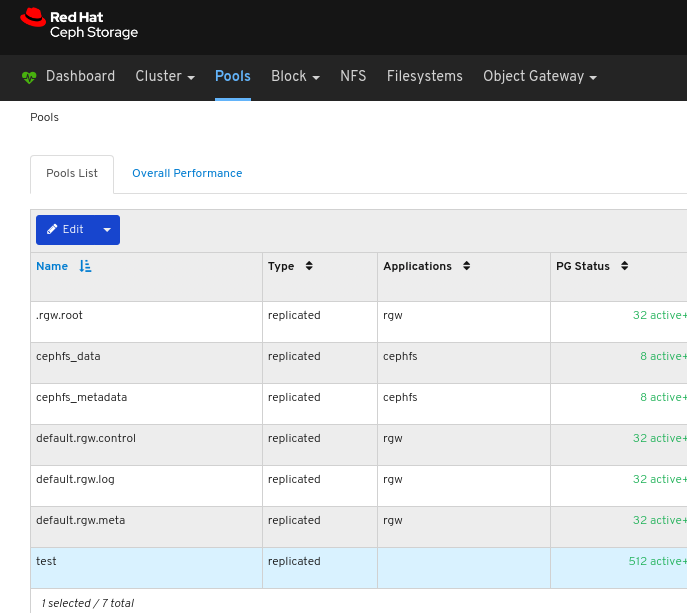

プールを削除するには、行をクリックします。

Edit ドロップダウンメニューで Delete を選択します。

Delete Pool ダイアログウィンドウで Yes, I am sure ボックスをクリックして Delete Pool をクリックし、設定を保存します。

ページの右上隅に対する通知は、プールが正常に削除されたことを示します。

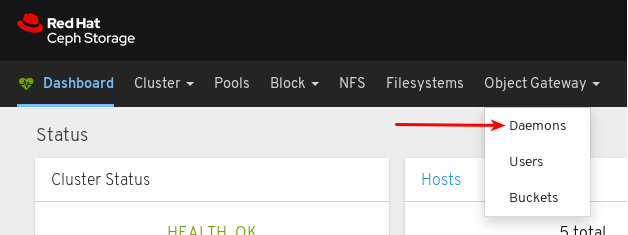

第8章 Object Gateway

ストレージ管理者は、ダッシュボードのObject Gateway 機能により、Ceph Object Gateway を管理および監視することができます。

たとえば、監視機能を使用すると、ゾーン名や GET および PUT レートのパフォーマンスグラフなどのゲートウェイデーモンの詳細を表示できます。管理機能を使用すると、ユーザーとバケットの両方を表示、作成、編集できます。

Object Gateway 機能は、デーモンの機能、ユーザー機能、およびバケット機能に分けられます。

8.1. 前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Ceph Object Gateway がインストールされている。

8.2. Object Gateway デーモン機能

ストレージ管理者は、Red Hat Ceph Storage Dashboard を使用して Ceph Object Gateway デーモンに関する情報を表示し、監視することができます。

8.2.1. 前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Ceph Object Gateway がインストールされている。

- Object Gateway のログイン認証情報がダッシュボードに追加されます。

8.2.2. Object Gateway デーモンの表示

ダッシュボードでは、全 Ceph Object Gateway デーモンの一覧を表示できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Ceph Object Gateway がインストールされている。

- Object Gateway のログイン認証情報がダッシュボードに追加されます。

手順

- ダッシュボードにログインします。

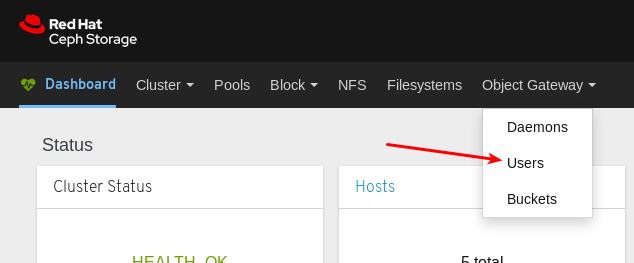

ナビゲーションバーで、Object Gateway をクリックします。

Daemons をクリックします。

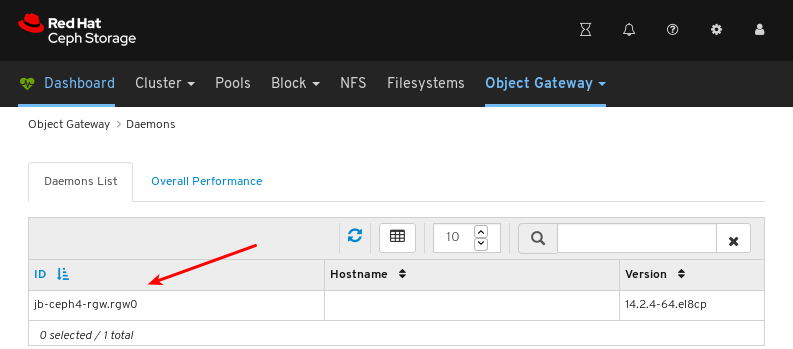

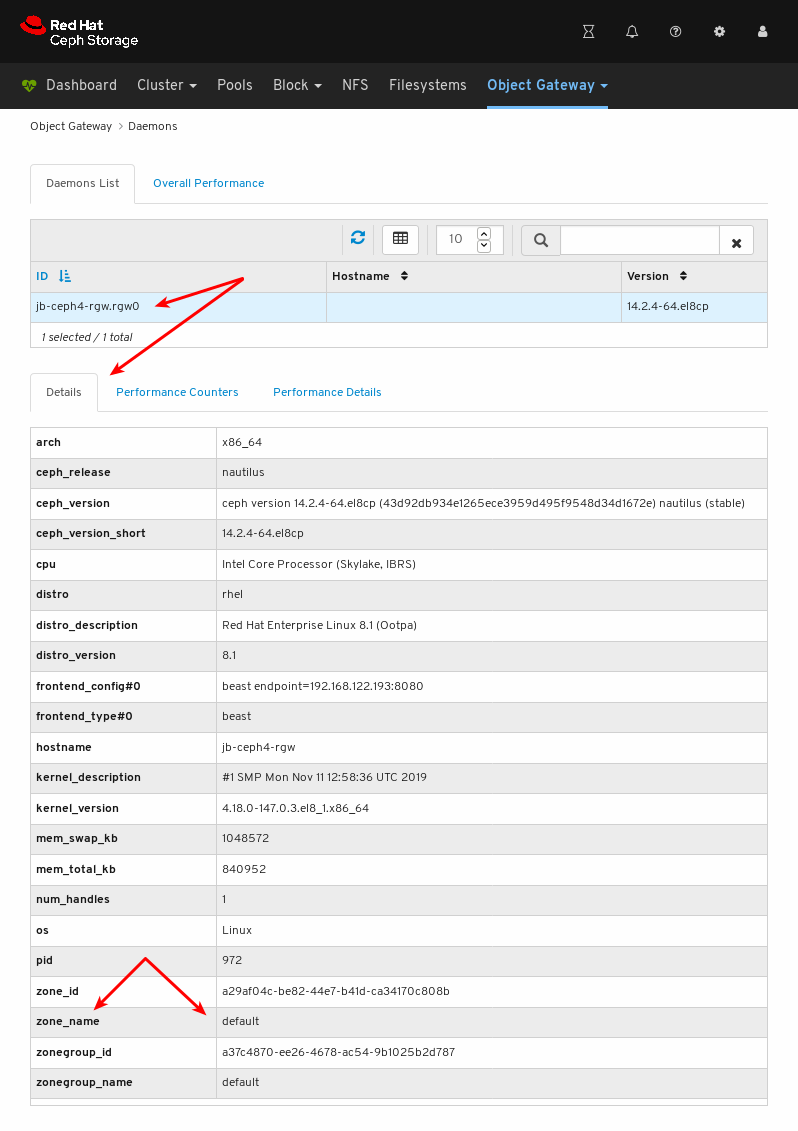

以下の例では、Daemons List に ID

jb-ceph4-rgw.rgw0のデーモンが表示されます。

詳細を表示するには、

jb-ceph4-rgw.rgw0の行をクリックしてデーモンを選択します。

デーモンがサービスしているゾーン名は

defaultであることを確認できます。

関連情報

- Ceph Object Gateway のインストール方法に関する情報は、インストールガイド の Ceph Object Gateway のインストール を参照してください。

- Object Gateway ログイン認証情報をダッシュボードに追加する方法については、ダッシュボードガイド の Dashboard へのObject Gateway ログイン認証情報の追加 を参照してください。

8.3. Object Gateway のユーザー機能

ストレージ管理者は、Red Hat Ceph Storage Dashboard を使用して Ceph Object Gateway ユーザーの表示および管理を行うことができます。

8.3.1. 前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Ceph Object Gateway がインストールされている。

- Object Gateway のログイン認証情報がダッシュボードに追加されます。

8.3.2. Object Gateway ユーザーの表示

ダッシュボードでは、全 Ceph Object Gateway ユーザーの一覧を表示できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Ceph Object Gateway がインストールされている。

- Object Gateway のログイン認証情報がダッシュボードに追加されます。

手順

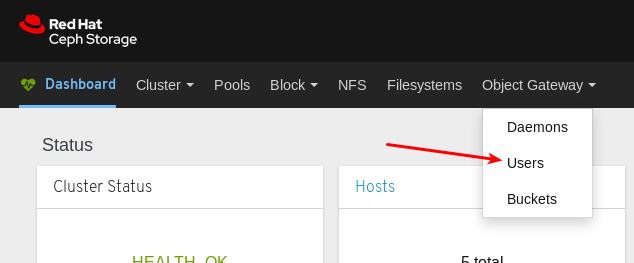

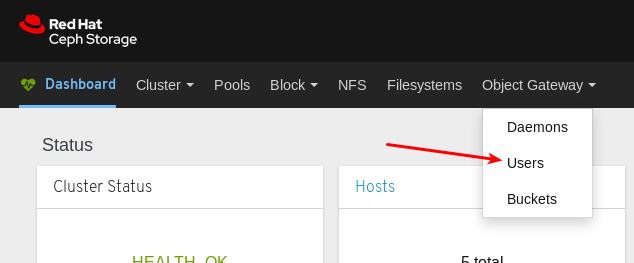

- ダッシュボードにログインします。

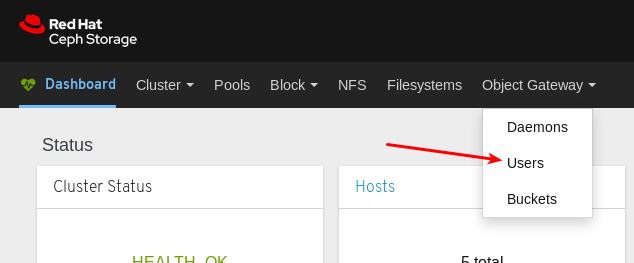

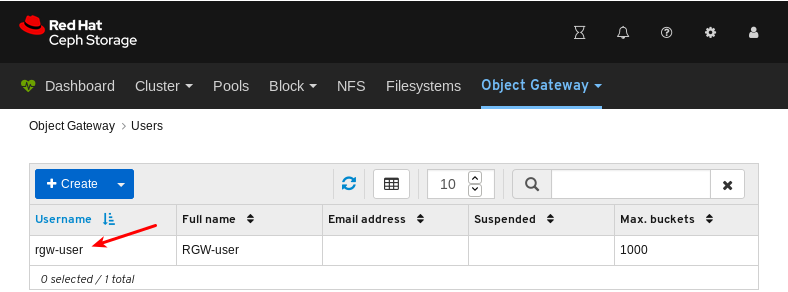

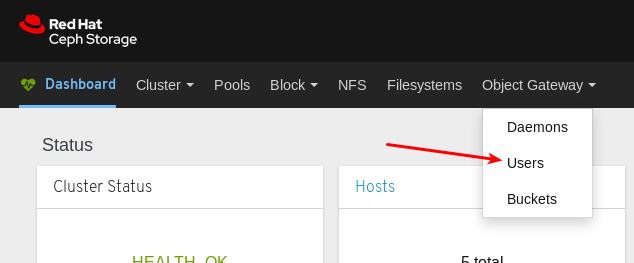

ナビゲーションバーで、Object Gateway をクリックします。

Users をクリックします。

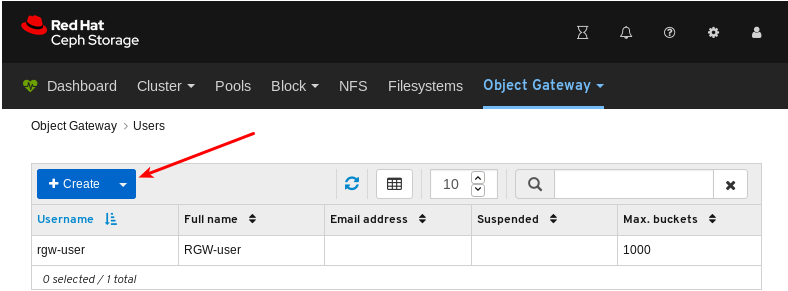

以下の例では、

rgw-userという名前のユーザーが表に表示されます。

詳細を表示するには、

rgw-userの行をクリックしてユーザーを選択します。

関連情報

- Ceph Object Gateway のインストール方法に関する情報は、インストールガイド の Ceph Object Gateway のインストール を参照してください。

- Object Gateway ログイン認証情報をダッシュボードに追加する方法については、ダッシュボードガイド の Dashboard へのObject Gateway ログイン認証情報の追加 を参照してください。

- Ceph Object Gateway の詳細は、Object Gateway の設定および管理ガイド を参照してください。

8.3.3. Object Gateway ユーザーの作成

ダッシュボードでは、Ceph Object Gateway ユーザーを作成できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Ceph Object Gateway がインストールされている。

- Object Gateway のログイン認証情報がダッシュボードに追加されます。

手順

- ダッシュボードにログインします。

ナビゲーションバーで、Object Gateway をクリックします。

Users をクリックします。

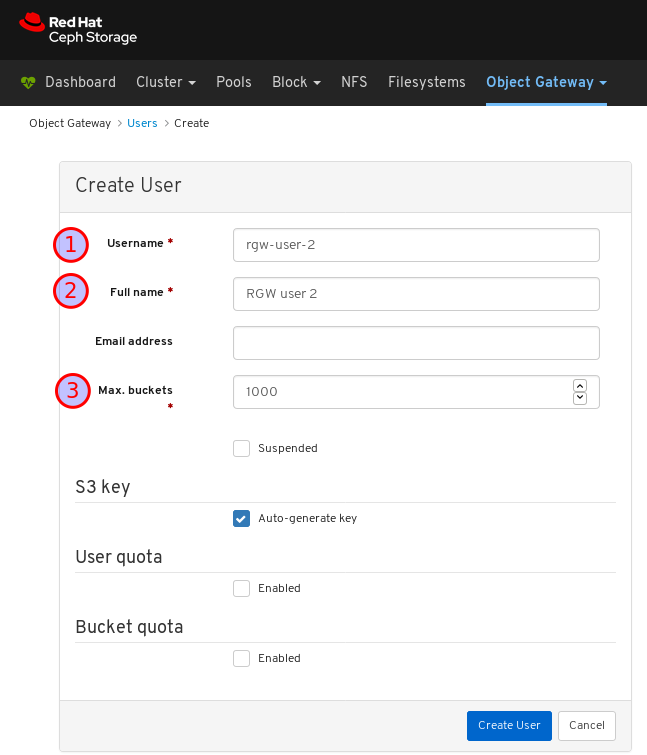

Create をクリックします。

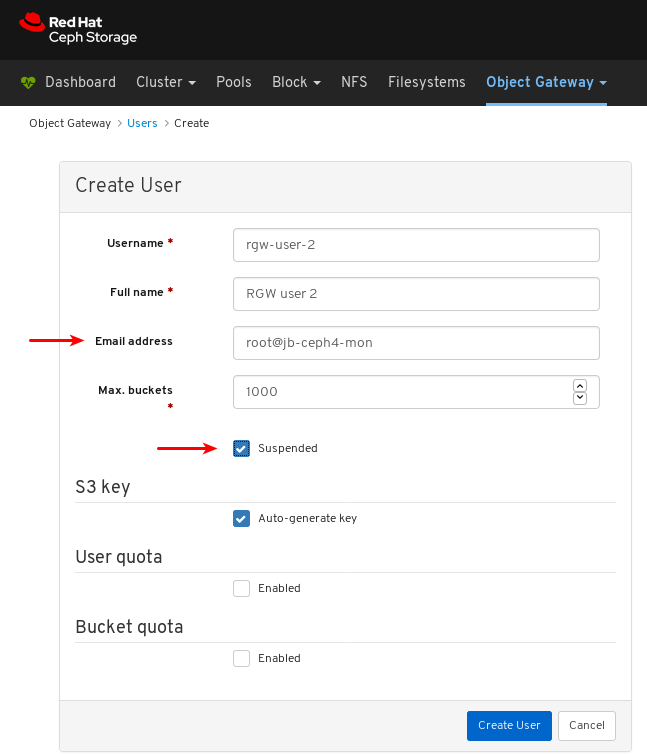

ユーザー名、フルネームを設定し、必要に応じてバケットの最大数を編集します。

必要に応じて、メールアドレスまたは一時停止のステータスを設定します。

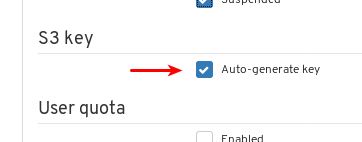

必要に応じて、Auto-generate key の選択を解除して、カスタムアクセスキーおよびシークレットキーを設定します。

自動生成キー の選択を解除します。

アクセスキーおよびシークレットキーを設定します。

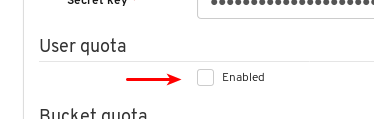

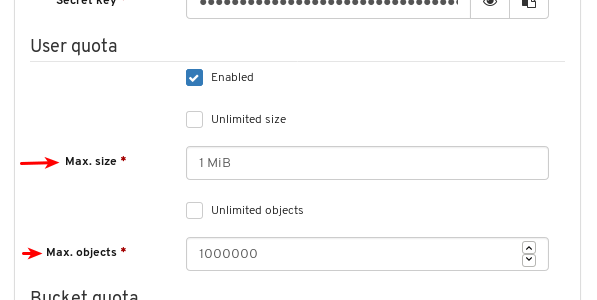

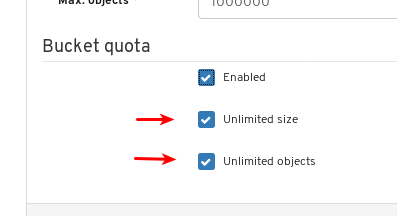

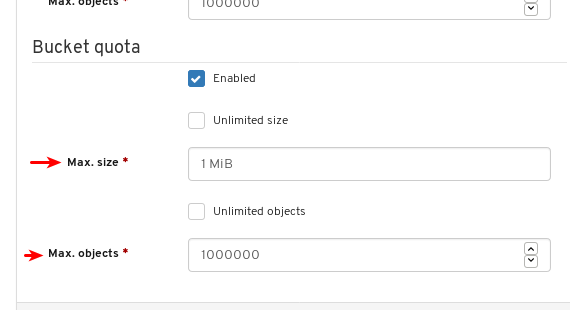

必要に応じて、ユーザークォータを設定します。

User quota で Enabled になっていることを確認します。

Unlimited size または Unlimited objects の選択を解除します。

Max. size または Max. objects に必要な値を入力します。

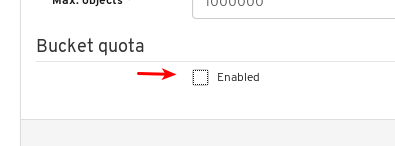

必要に応じて、バケットクォータを設定します。

Bucket quota で Enabled になっていることを確認します。

Unlimited size または Unlimited objects の選択を解除します。

Max. size または Max. objects に必要な値を入力します。

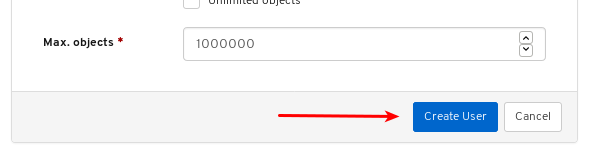

ユーザーの作成の最終処理を行うには、Create User をクリックします。

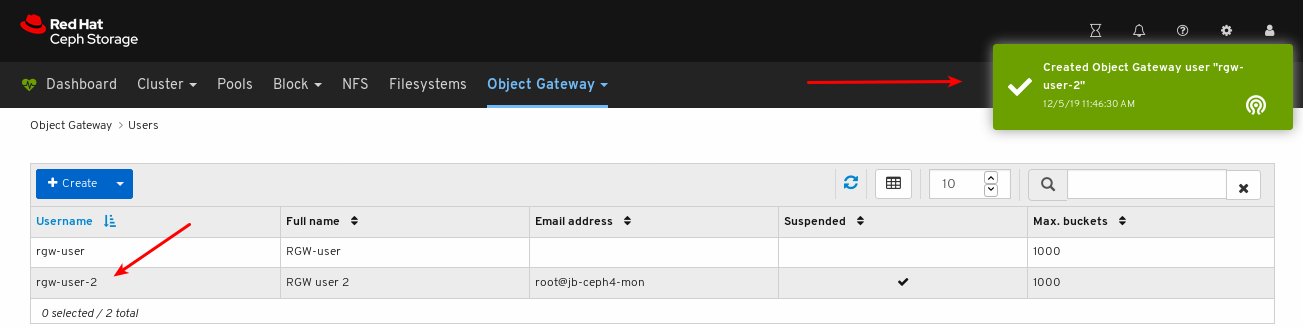

ユーザー作成が正常に行われたことを確認します。通知では、ユーザーが作成され、ユーザーのテーブルに表示されることを確認します。

関連情報

- Ceph Object Gateway のインストール方法に関する情報は、インストールガイド の Ceph Object Gateway のインストール を参照してください。

- Object Gateway ログイン認証情報をダッシュボードに追加する方法については、ダッシュボードガイド の Dashboard へのObject Gateway ログイン認証情報の追加 を参照してください。

- Ceph Object Gateway の詳細は、Object Gateway の設定および管理ガイド を参照してください。

8.3.4. Object Gateway ユーザーの編集

ダッシュボードでは、Ceph Object Gateway ユーザーを編集できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Ceph Object Gateway がインストールされている。

- Object Gateway のログイン認証情報がダッシュボードに追加されます。

- Ceph Object Gateway ユーザーが作成されている。

手順

- Dashboard にログインします。

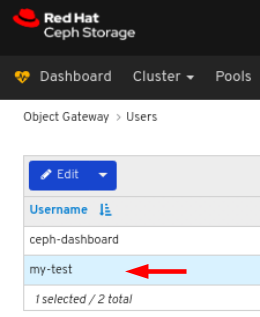

ナビゲーションバーで、Object Gateway をクリックします。

Users をクリックします。

ユーザー機能を編集するには、その行をクリックします。

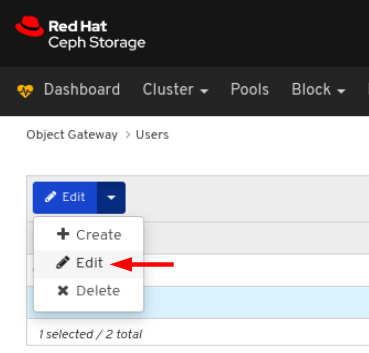

Edit ドロップダウンメニューで Edit を選択します。

EditUser ウィンドウで必要なパラメーターを編集して、EditUser ボタンをクリックします。

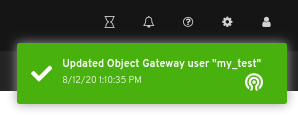

ページの右上隅に対する通知は、ユーザーが正常に更新されたことを示しています。

8.3.5. Object Gateway ユーザーの削除

ダッシュボードでは、Ceph Object Gateway ユーザーを削除できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Ceph Object Gateway がインストールされている。

- Object Gateway のログイン認証情報がダッシュボードに追加されます。

- Ceph Object Gateway ユーザーが作成されている。

手順

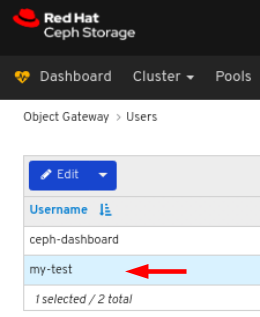

- Dashboard にログインします。

ナビゲーションバーで、Object Gateway をクリックします。

Users をクリックします。

ユーザーを削除するには、その行をクリックします。

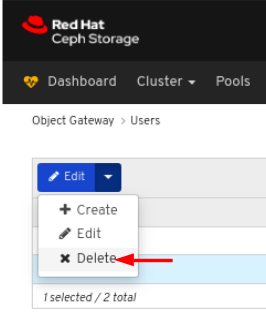

Edit ドロップダウンメニューで Delete を選択します。

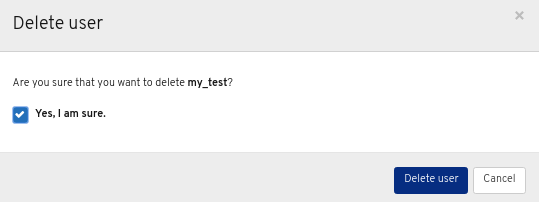

Delete User ダイアログウィンドウで Yes, I am sure ボックスをクリックして Delete User クリックし、設定を保存します。

8.3.6. Object Gateway サブユーザーの作成

サブユーザーは、S3 インターフェイスのユーザーに関連付けられます。ダッシュボードでは、Ceph Object Gateway サブユーザーを作成できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Ceph Object Gateway がインストールされている。

- Object Gateway のログイン認証情報がダッシュボードに追加されます。

- Object Gateway ユーザーが作成されている。

手順

- ダッシュボードにログインします。

ナビゲーションバーで、Object Gateway をクリックします。

ドロップダウンメニューの Users をクリックします。

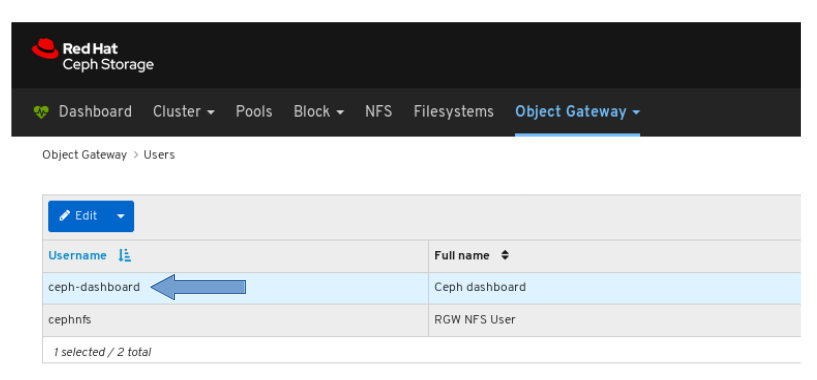

以下の例では、

ceph-dashboardという名前のユーザーが表に表示されます。行をクリックしてユーザーを選択します。

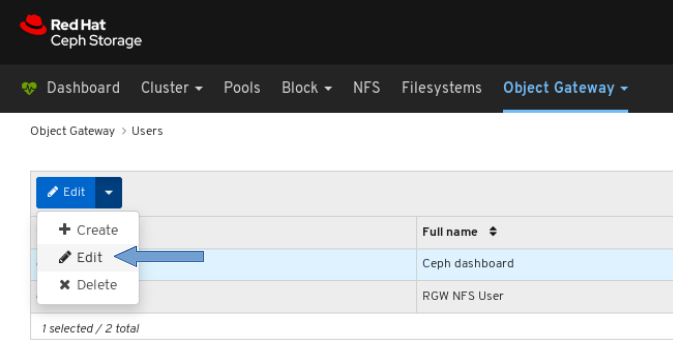

Edit ドロップダウンメニューをクリックして Edit を選択します。

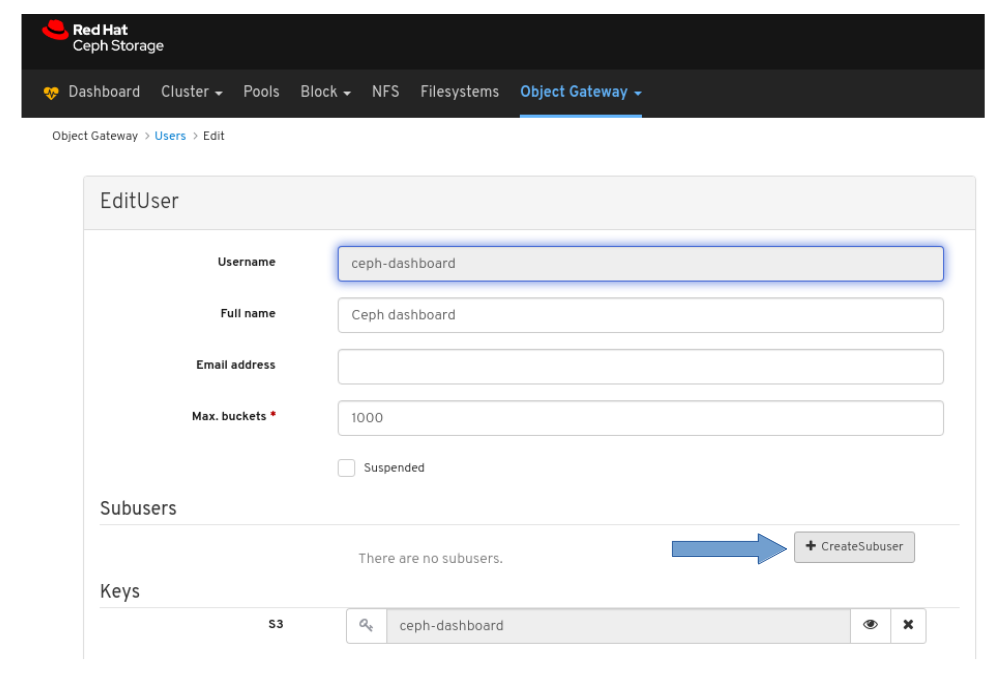

+CreateSubuser ボタンをクリックします。

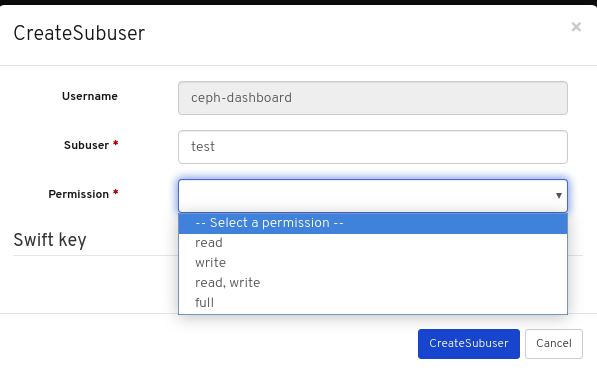

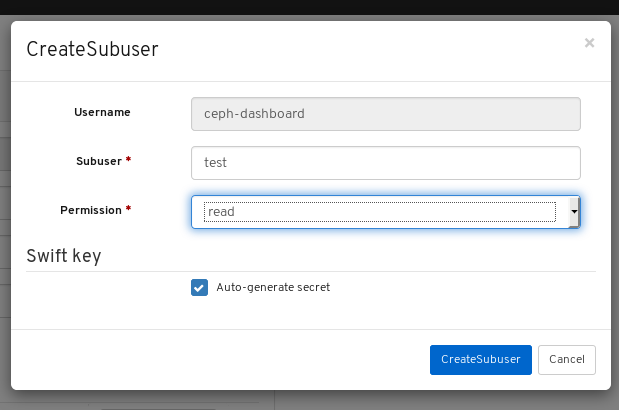

サブユーザー 名を入力し、適切なパーティションを選択します。

自動生成シークレット ボックスをクリックし、Create Subuser ボタンをクリックします。

注記

注記Auto-generate-secret チェックボックスをクリックすると、Object Gateway の秘密鍵が自動的に生成されます。

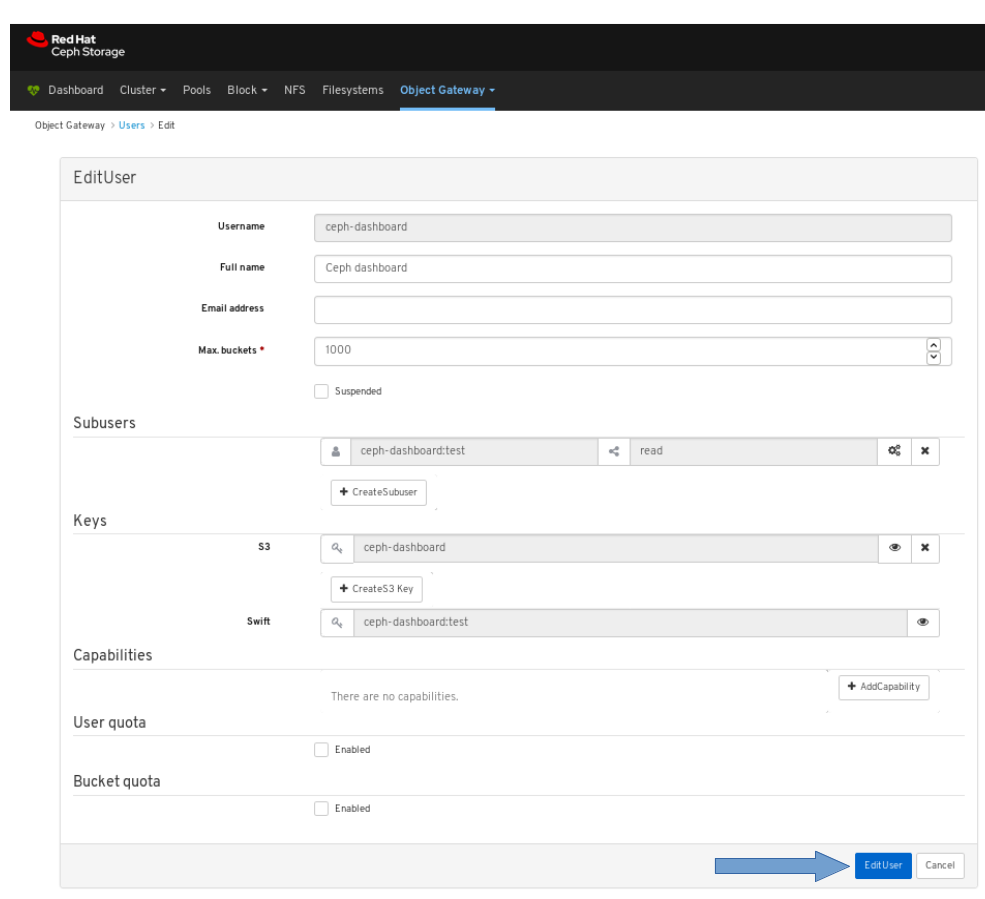

Edit User ウィンドウで Edit user ボタンをクリックします。

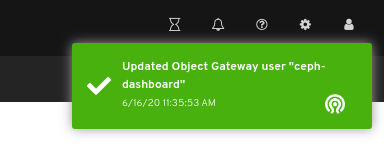

サブユーザーの作成が正常に行われたことを確認します。ページの右上隅にある通知がポップアップ表示され、Object Gateway ユーザーが正常に更新されたことを示します。

関連情報

- Ceph Object Gateway のインストール方法は、Red Hat Ceph Storage インストールガイド の Ceph Object Gateway のインストール を参照してください。

- Object Gateway ログイン認証情報を手動でダッシュボードに追加する方法は、ダッシュボードガイド の ダッシュボードにObject Gateway のログイン認証情報を手動で追加 を参照してください。

- Ceph Object Gateway の詳細は、Object Gateway の設定および管理ガイドを参照してください。

8.4. Object Gateway のバケット機能

ストレージ管理者は、Red Hat Ceph Storage Dashboard を使用して Ceph Object Gateway バケットを表示し、管理できます。

8.4.1. 前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Ceph Object Gateway がインストールされている。

- Object Gateway のログイン認証情報がダッシュボードに追加されます。

8.4.2. Object Gateway のバケットの表示

ダッシュボードでは、Ceph Object Gateway バケットを表示し、管理できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Ceph Object Gateway がインストールされている。

- Object Gateway のログイン認証情報がダッシュボードに追加されます。

- Object Gateway バケットが作成されている。

手順

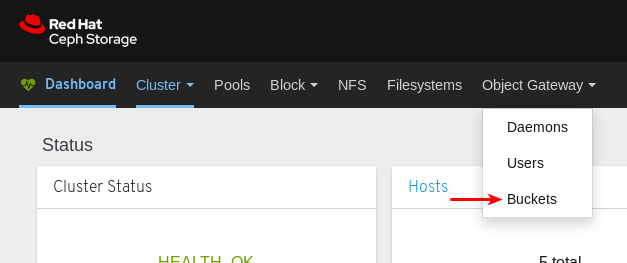

- ダッシュボードにログインします。

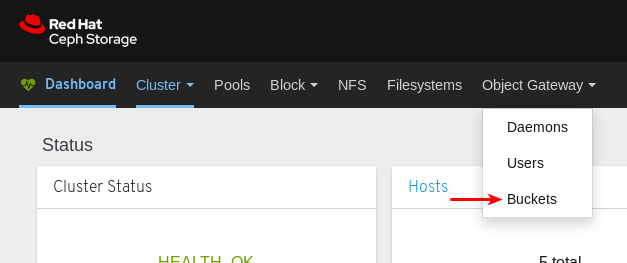

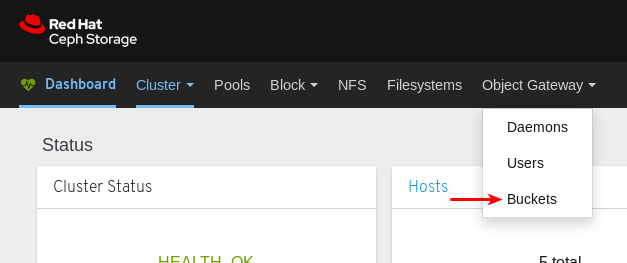

ナビゲーションバーで、Object Gateway をクリックします。

Buckets をクリックします。

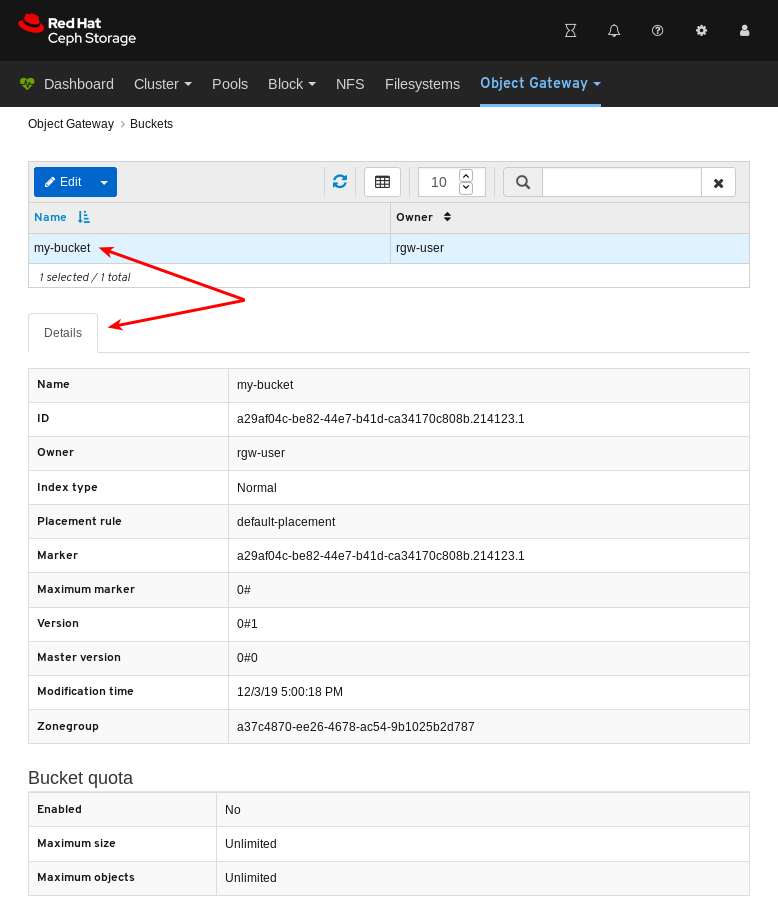

以下の例では、テーブルに

my-bucketという名前のバケットを確認できます。

詳細を表示するには、

my-bucketの行をクリックしてバケットを選択します。

関連情報

- Ceph Object Gateway のインストール方法に関する情報は、インストールガイド の Ceph Object Gateway のインストール を参照してください。

- Object Gateway ログイン認証情報をダッシュボードに追加する方法については、ダッシュボードガイド の Dashboard へのObject Gateway ログイン認証情報の追加 を参照してください。

- Ceph Object Gateway の詳細は、Object Gateway の設定および管理ガイド を参照してください。

8.4.3. Object Gateway のバケットの作成

ダッシュボードでは、Ceph Object Gateway バケットを作成できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Ceph Object Gateway がインストールされている。

- Object Gateway のログイン認証情報がダッシュボードに追加されます。

- 一時停止していないObject Gateway ユーザーが作成されます。

手順

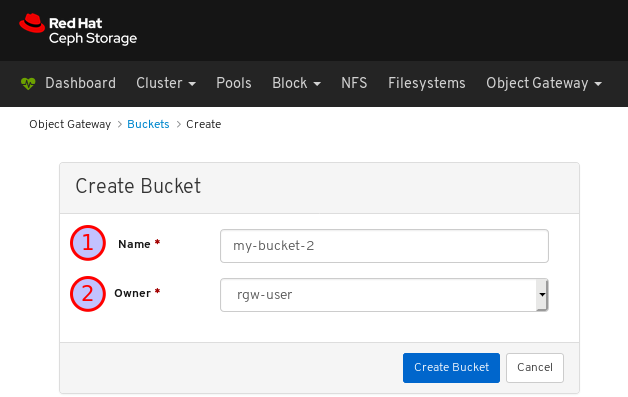

- ダッシュボードにログインします。

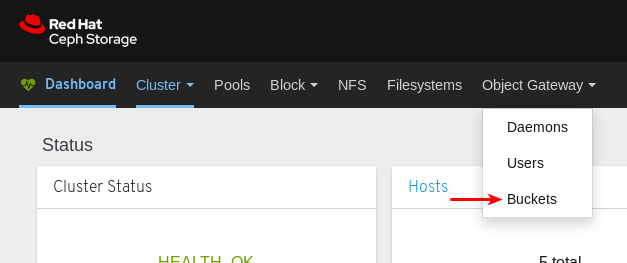

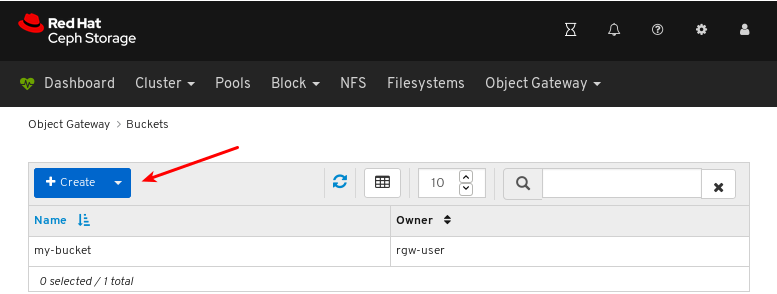

ナビゲーションバーで、Object Gateway をクリックします。

Buckets をクリックします。

Create をクリックします。

Name に値を入力し、一時停止していないユーザーを選択します。

Create bucket をクリックします。

バケットの作成が正常に行われたことを確認します。バケットが作成されたことを確認する通知が表示され、バケットはバケットのテーブルに表示されます。

関連情報

- Ceph Object Gateway のインストール方法に関する情報は、インストールガイド の Ceph Object Gateway のインストール を参照してください。

- Object Gateway ログイン認証情報をダッシュボードに追加する方法については、ダッシュボードガイド の Dashboard へのObject Gateway ログイン認証情報の追加 を参照してください。

- Ceph Object Gateway の詳細は、Object Gateway の設定および管理ガイド を参照してください。

8.4.4. Object Gateway バケットの編集

ダッシュボードでは、Ceph Object Gateway バケットを編集できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Ceph Object Gateway がインストールされている。

- Object Gateway のログイン認証情報がダッシュボードに追加されます。

- 一時停止していない Ceph Object Gateway ユーザーが作成されている。

- Ceph Object Gateway バケットが作成されている。

手順

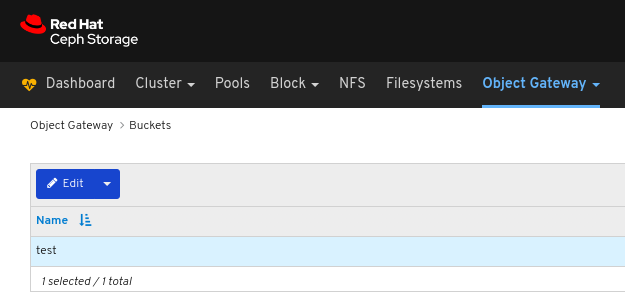

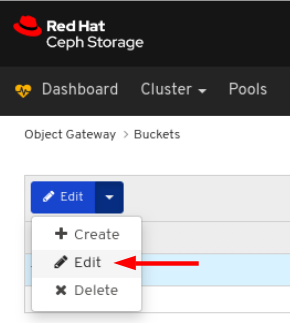

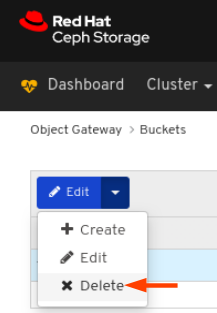

- Dashboard にログインします。

ナビゲーションバーで、Object Gateway をクリックします。

Buckets をクリックします。

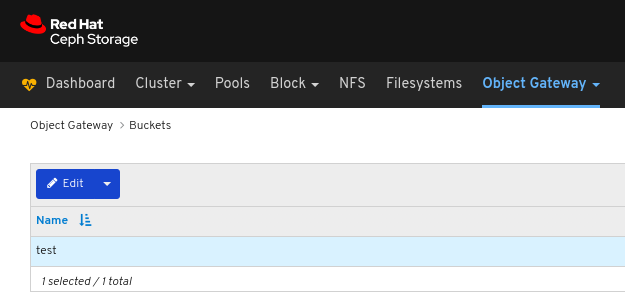

バケットを編集するには、その行をクリックします。

Edit ドロップダウンメニューで Edit を選択します。

EditBucket ウィンドウで、必要なパラメーターを編集して EditBucket ボタンをクリックします。

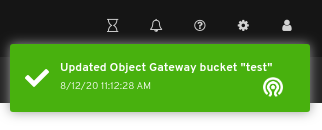

ページの右上隅に対する通知は、バケットが正常に更新されたことを示します。

関連情報

- 詳細は、Red Hat Ceph Storage インストールガイドの Ceph Object Gateway のインストール セクションを参照してください。

- 詳細は、Red Hat Ceph Storage ダッシュボードガイドの ダッシュボードにObject Gateway のログイン認証情報を追加 セクションを参照してください。

8.4.5. Object Gateway バケットの削除

ダッシュボードでは、Ceph Object Gateway バケットを削除できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Ceph Object Gateway がインストールされている。

- Object Gateway のログイン認証情報がダッシュボードに追加されます。

- 一時停止していない Ceph Object Gateway ユーザーが作成されている。

- Ceph Object Gateway バケットが作成されている。

手順

- Dashboard にログインします。

ナビゲーションバーで、Object Gateway をクリックします。

Buckets をクリックします。

バケットを削除するには、その行をクリックします。

Edit ドロップダウンメニューで Delete を選択します。

Delete Bucket ダイアログウィンドウで Yes, I am sure ボックスをクリックして Delete bucket クリックし、設定を保存します。

8.5. Object Gateway ログイン認証情報をダッシュボードに手動で追加

Red Hat Ceph Storage Dashboard は、RADOS Gateway または RGW として知られる Ceph Object Gateway を管理できます。Ceph Object Gateway を管理するには、ダッシュボードは system フラグを使用して RGW ユーザーのログイン認証情報を使用して接続する必要があります。ceph-ansible を使用して Object Gateway をインストールすると、自動的にログイン認証情報がダッシュボードに追加されます。ログインの認証情報を手動で設定することもできます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- Ceph Object Gateway がインストールされている。

手順

systemフラグを有効にして RGW ユーザーのaccess_keyおよびsecret_keyを取得します。systemフラグを有効にしている RGW ユーザーがない場合は、これを作成します。radosgw-admin user create --uid=USER_ID --display-name=DISPLAY_NAME --system

radosgw-admin user create --uid=USER_ID --display-name=DISPLAY_NAME --systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow access_keyおよびsecret_keyの値を書き留めます。上記の例では、access_keyはBYC5SWQQH24A2BFHS2RCで、secret_keyは159d94uHK9ADiWZrGsNYWYjRXCDrhL2xVi8PO6kTです。systemフラグが有効な RGW ユーザーがすでに作成されている場合は、radosgw-adminユーティリティーのuser infoコマンドを使用して認証情報を取得します。radosgw-admin user info --uid=USER_ID

radosgw-admin user info --uid=USER_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow access_keyおよびsecret_keyの値を書き留めます。上記の例では、access_keyはBYC5SWQQH24A2BFHS2RCで、secret_keyは159d94uHK9ADiWZrGsNYWYjRXCDrhL2xVi8PO6kTです。

access_keyおよびsecret_keyの認証情報をダッシュボードに指定します。ダッシュボードに

access_keyを指定します。ceph dashboard set-rgw-api-access-key ACCESS_KEY

ceph dashboard set-rgw-api-access-key ACCESS_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

ceph dashboard set-rgw-api-access-key BYC5SWQQH24A2BFHS2RC Option RGW_API_ACCESS_KEY updated

[root@mon ~]# ceph dashboard set-rgw-api-access-key BYC5SWQQH24A2BFHS2RC Option RGW_API_ACCESS_KEY updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow secret_keyをダッシュボードに指定します。ceph dashboard set-rgw-api-secret-key SECRET_KEY

ceph dashboard set-rgw-api-secret-key SECRET_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

ceph dashboard set-rgw-api-secret-key 159d94uHK9ADiWZrGsNYWYjRXCDrhL2xVi8PO6kT Option RGW_API_SECRET_KEY updated

[root@mon ~]# ceph dashboard set-rgw-api-secret-key 159d94uHK9ADiWZrGsNYWYjRXCDrhL2xVi8PO6kT Option RGW_API_SECRET_KEY updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Object Gateway のホスト名およびポートをダッシュボードに指定します。

ダッシュボードにホスト名を指定します。

ceph dashboard set-rgw-api-host HOST_NAME

ceph dashboard set-rgw-api-host HOST_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

ceph dashboard set-rgw-api-host 192.168.122.193 Option RGW_API_HOST updated

[root@mon ~]# ceph dashboard set-rgw-api-host 192.168.122.193 Option RGW_API_HOST updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow ポートをダッシュボードに指定します。

ceph dashboard set-rgw-api-port PORT

ceph dashboard set-rgw-api-port PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

ceph dashboard set-rgw-api-port 8080 Option RGW_API_PORT updated

[root@mon ~]# ceph dashboard set-rgw-api-port 8080 Option RGW_API_PORT updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

必要に応じて、自己署名証明書と共に HTTPS を使用している場合は、ダッシュボードで証明書の検証を無効にして、拒否された接続を回避します。

証明書が不明な認証局によって署名されている場合や、使用するホスト名が証明書のホスト名と一致しない場合は、拒否される接続が発生する可能性があります。

ceph dashboard set-rgw-api-ssl-verify false

ceph dashboard set-rgw-api-ssl-verify falseCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

ceph dashboard set-rgw-api-ssl-verify false Option RGW_API_SSL_VERIFY updated

[root@mon ~]# ceph dashboard set-rgw-api-ssl-verify false Option RGW_API_SSL_VERIFY updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

関連情報

- Ceph Object Gateway のインストール方法に関する情報は、インストールガイド の Ceph Object Gateway のインストール を参照してください。

- Ceph Object Gateway の詳細は、Object Gateway の設定および管理ガイド を参照してください。

第9章 ブロックデバイス

9.1. ブロックデバイスの概要

ダッシュボードのブロックデバイス機能により、ブロックデバイスイメージを管理および監視できます。この機能は、一般的なイメージ機能、ミラーリング機能、iSCSI 機能、およびサービスの品質設定に分けられます。たとえば、新規イメージの作成、クラスター間でミラーリングされたイメージの状態の表示、iSCSI ターゲットの管理または監視、およびイメージでの IOPS 制限の設定を行うことができます。

9.2. イメージ関数

ダッシュボードは、イメージの管理および監視に関連する複数の機能を提供します。

9.2.1. 前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

9.2.2. イメージの作成

ダッシュボードでは、イメージを作成できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- rbd アプリケーションが有効になっているプールが作成されている。

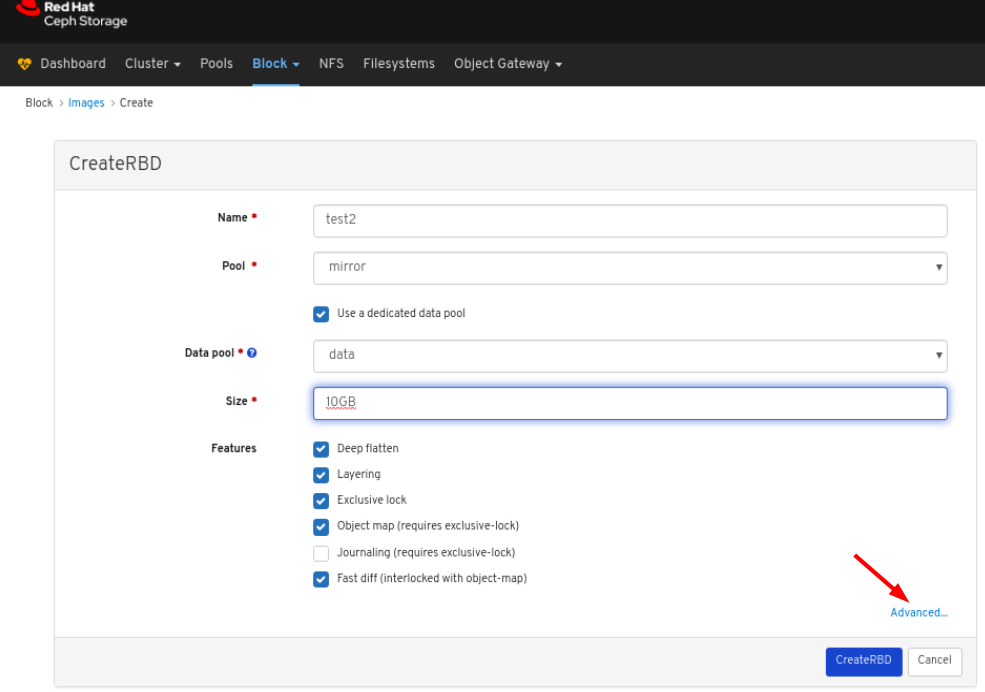

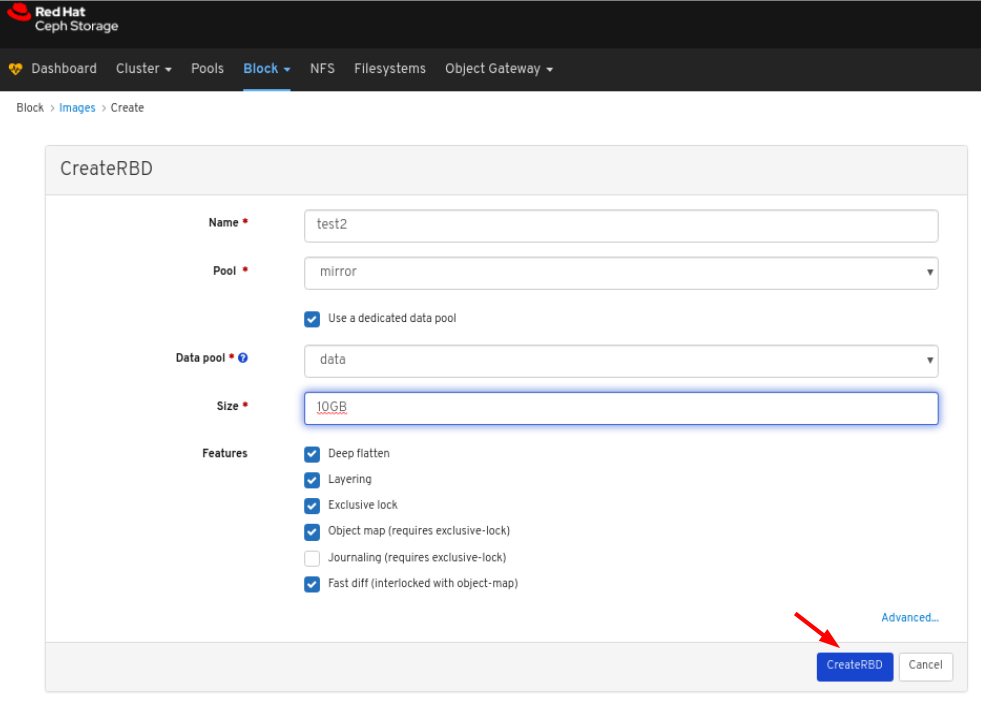

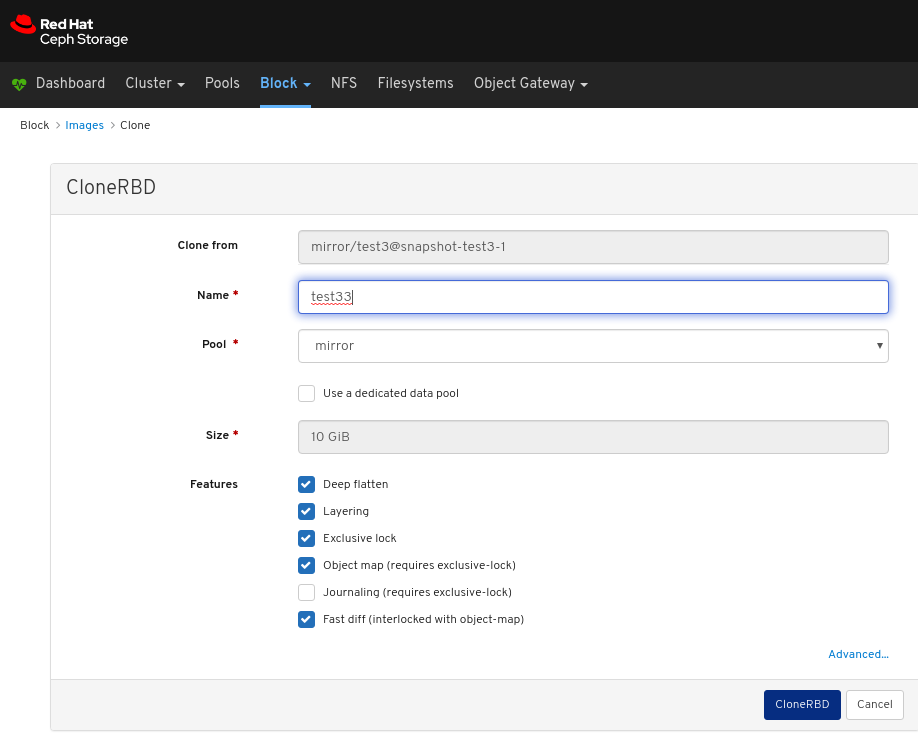

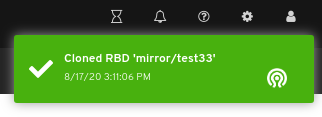

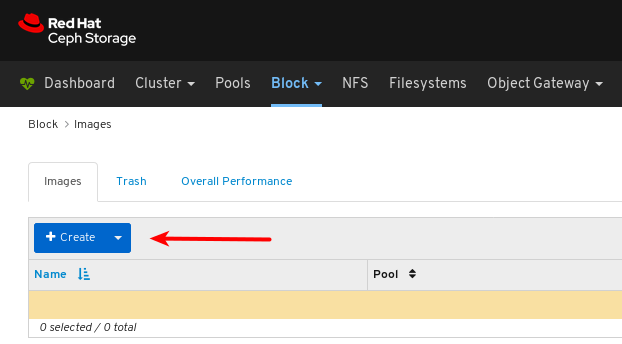

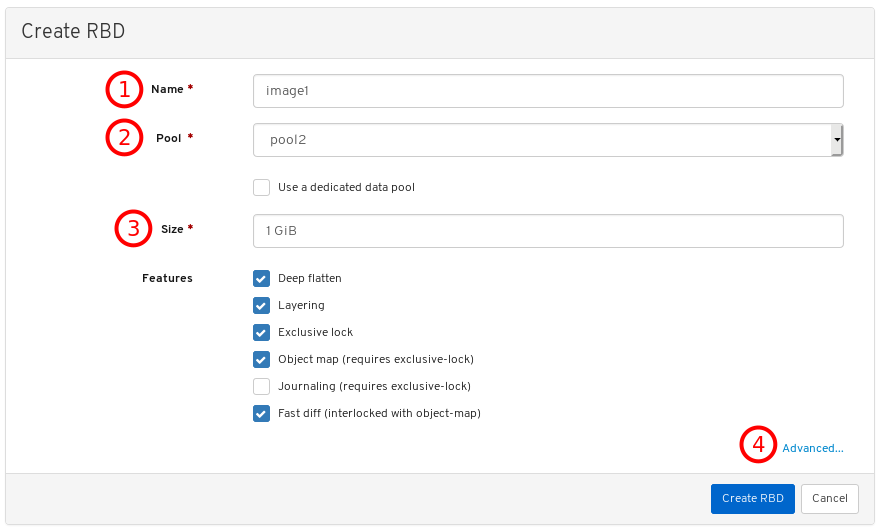

手順

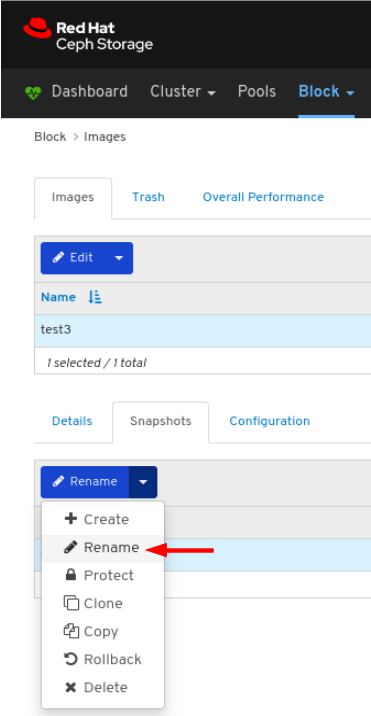

- Dashboard にログインします。

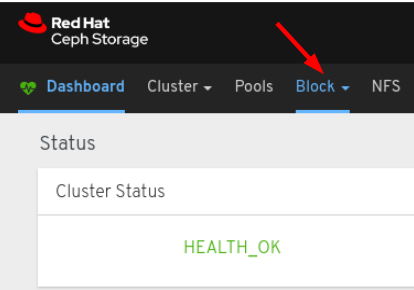

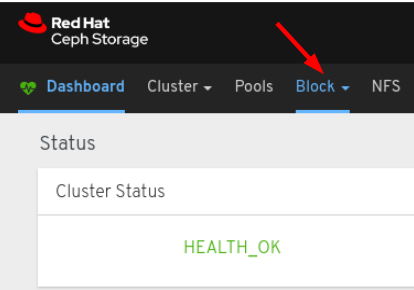

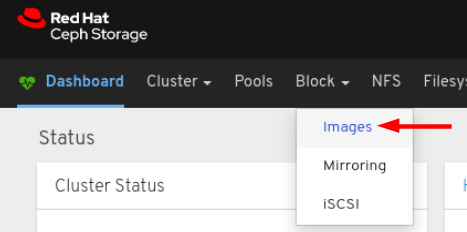

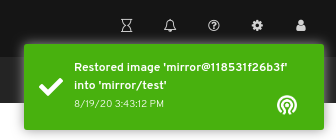

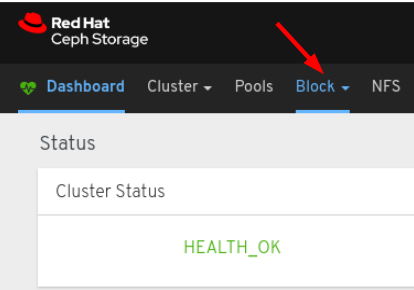

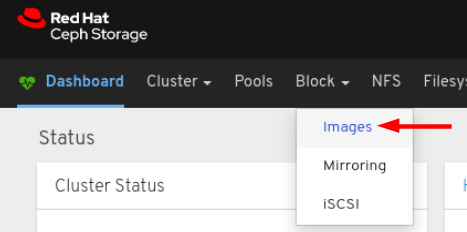

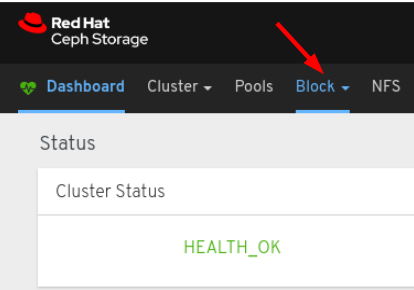

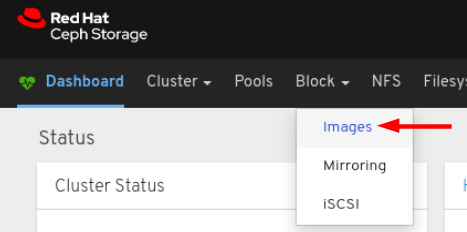

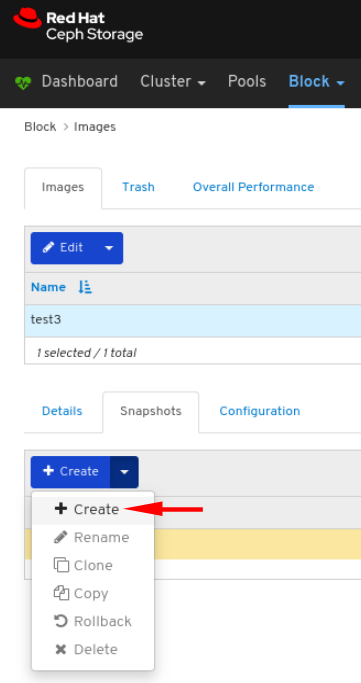

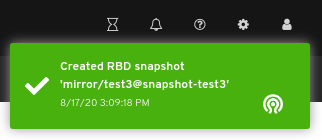

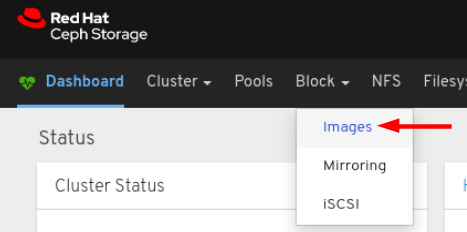

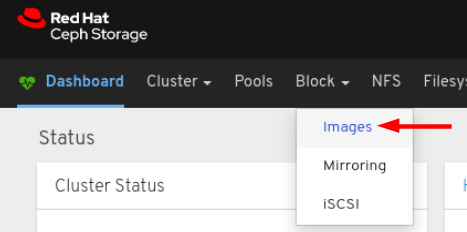

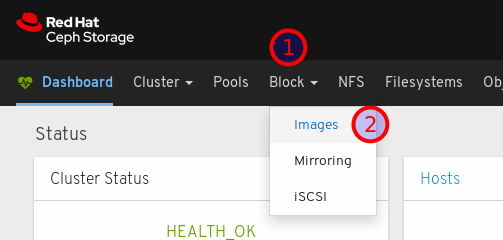

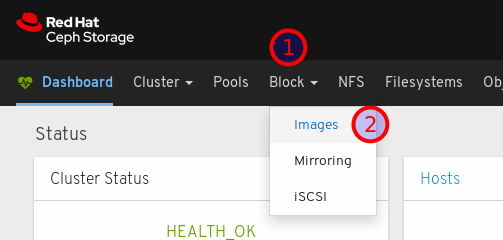

ナビゲーションバーで、Block をクリックします。

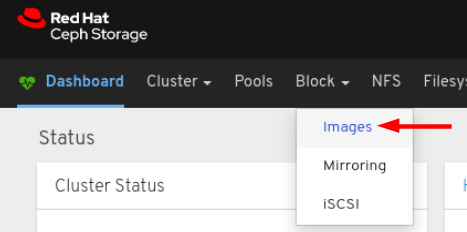

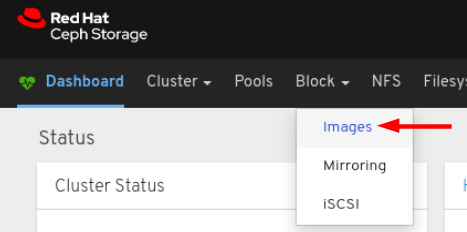

ドロップダウンから Images を選択します。

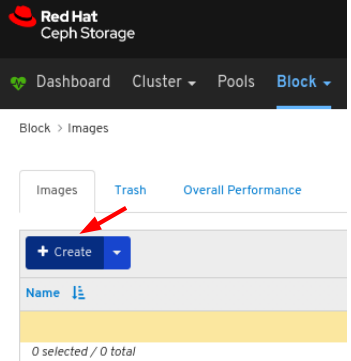

Images タブで、Create ボタンをクリックします。

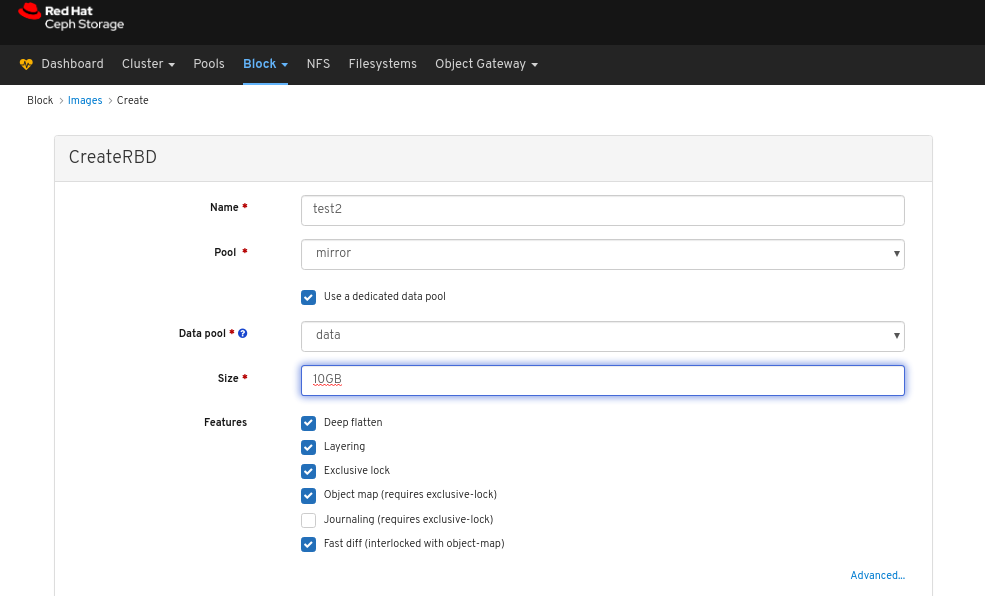

CreateRBD ウィンドウで、パラメーターを入力します。

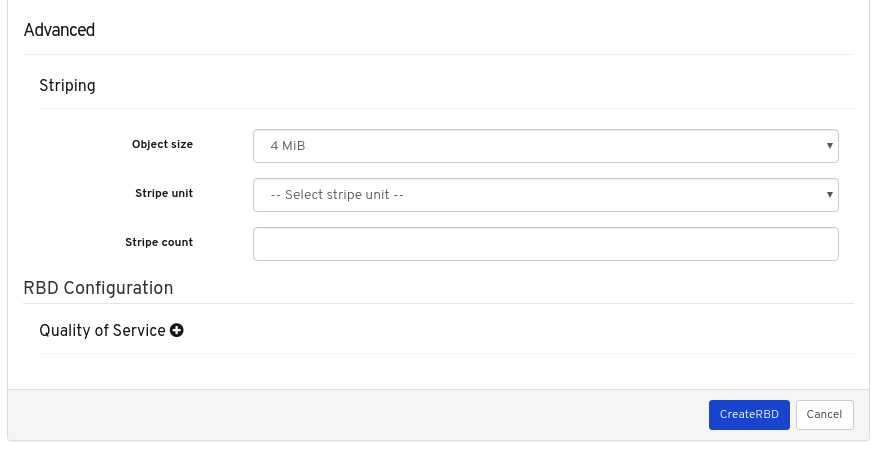

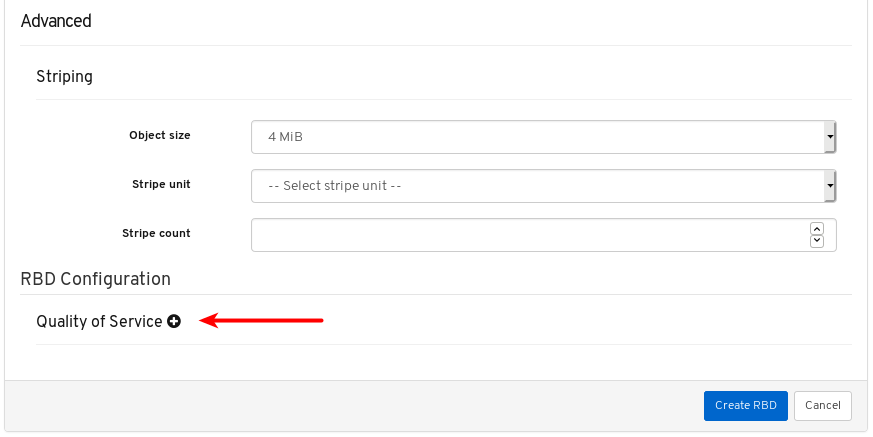

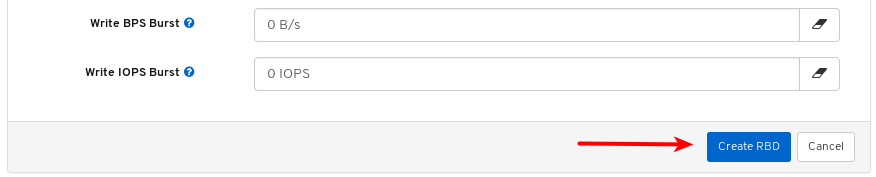

必要に応じて Advanced をクリックし、パラメーターを設定します。

CreateRBD ボタンをクリックします。

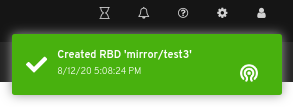

ページの右上隅に対する通知は、イメージが正常に作成されたことを示しています。

関連情報

- イメージの詳細は、Red Hat Ceph Storage ブロックデバイスガイド を参照してください。

- RBD プールの作成に関する詳細は、Red Hat Ceph Storage ダッシュボードガイドの プールの作成 セクションを参照してください。

9.2.3. イメージの表示

ダッシュボードでは、イメージを表示できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- イメージがクラスターにある。

手順

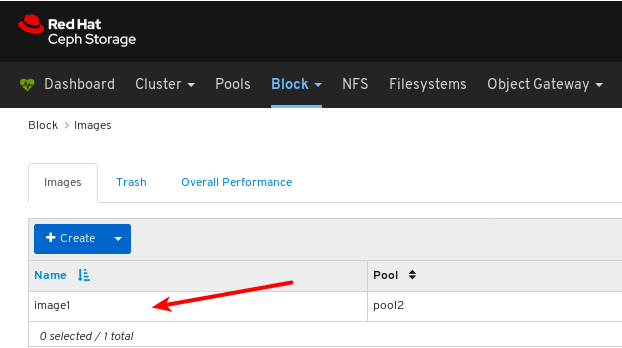

- Dashboard にログインします。

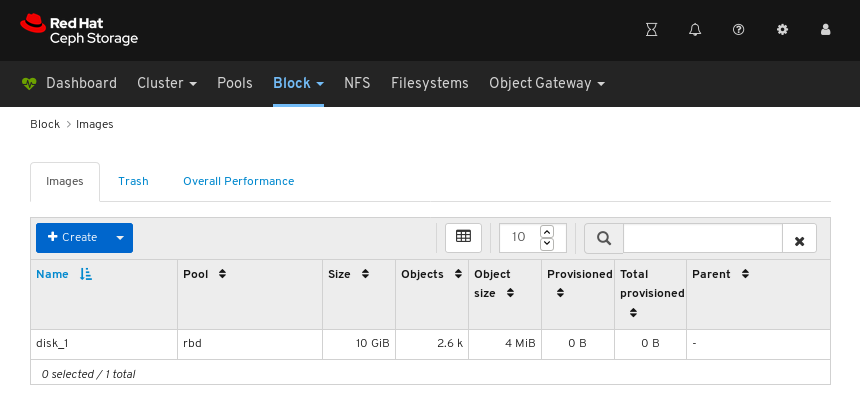

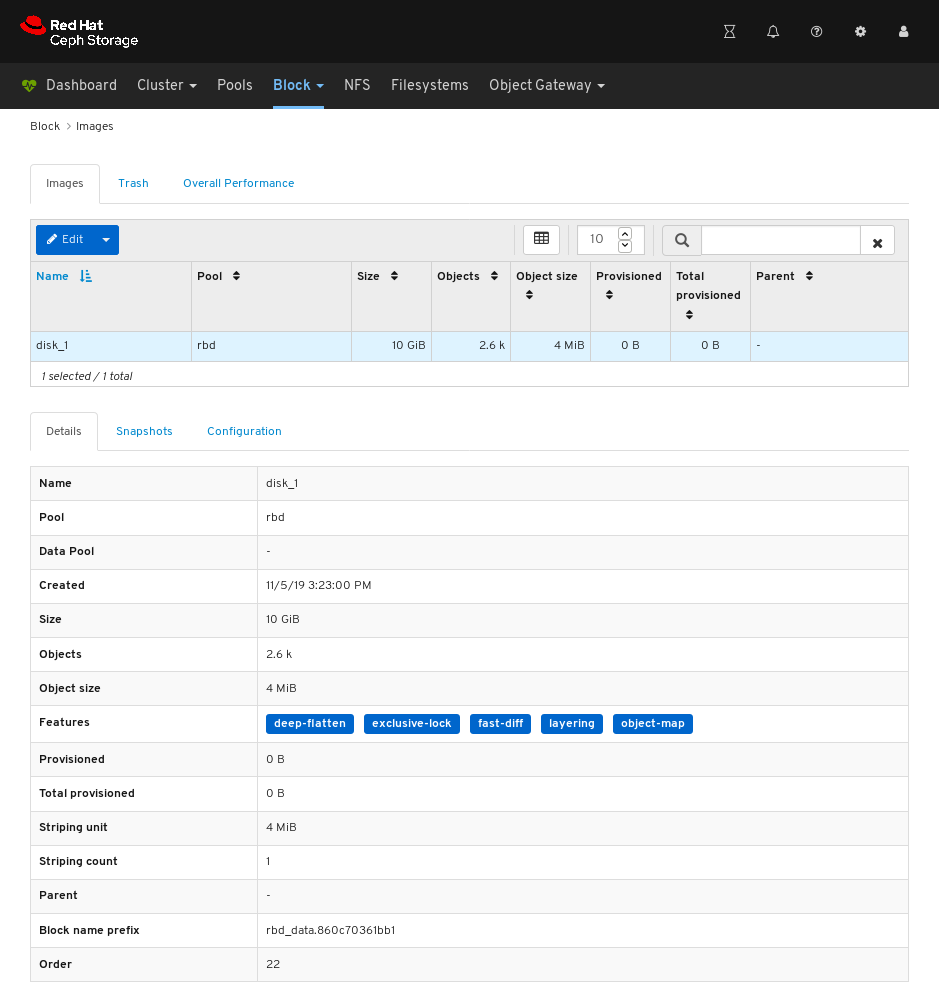

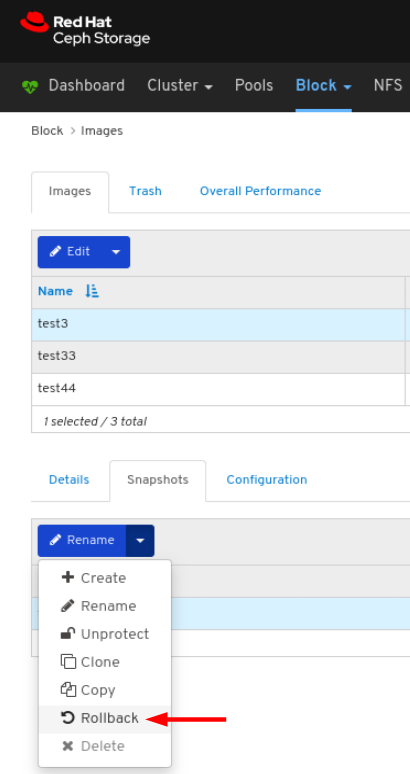

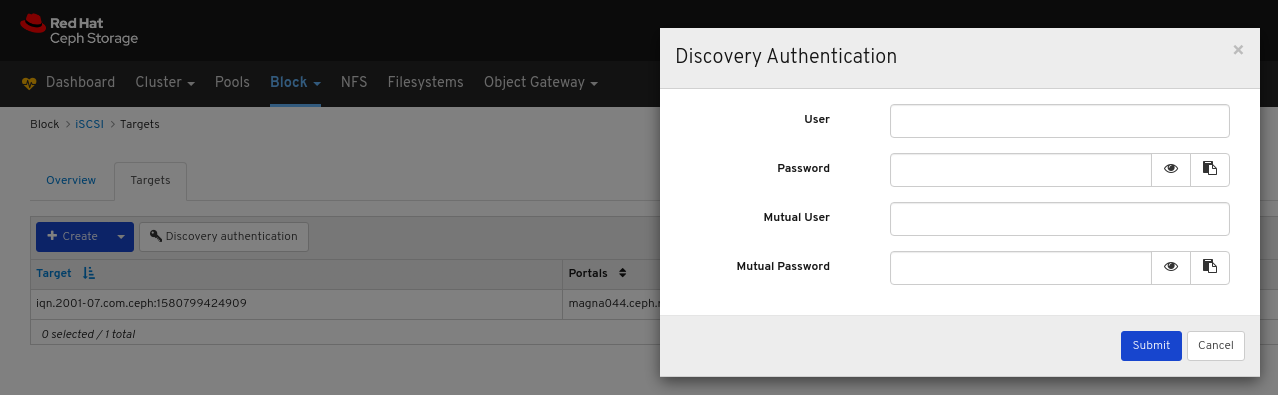

- ナビゲーションバーで Block をクリックします。

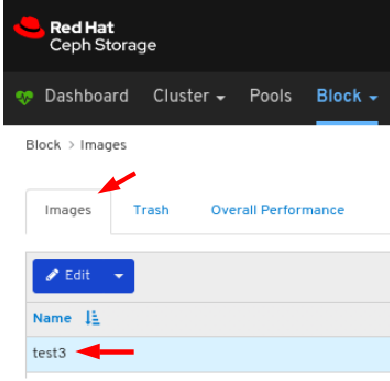

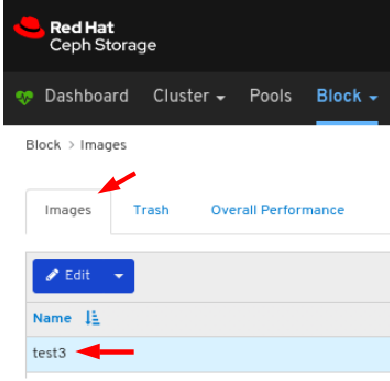

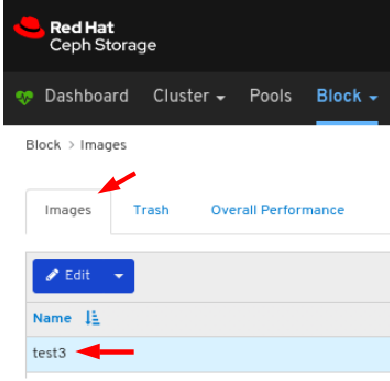

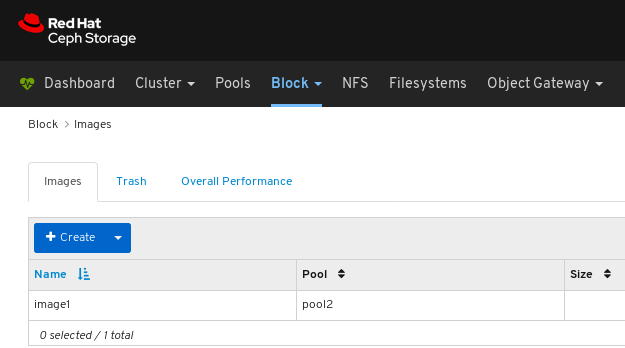

Images をクリックします。

上記の例では、disk_1 という名前の 10 GiB イメージを確認できます。

詳細を表示するには、disk_1 の行をクリックしてイメージを選択します。

関連情報

- イメージの詳細は、ブロックデバイスガイド を参照してください。

9.2.4. イメージの編集

ダッシュボードでは、イメージを編集できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- rbd アプリケーションが有効になっているプールが作成されている。

- イメージが作成されている。

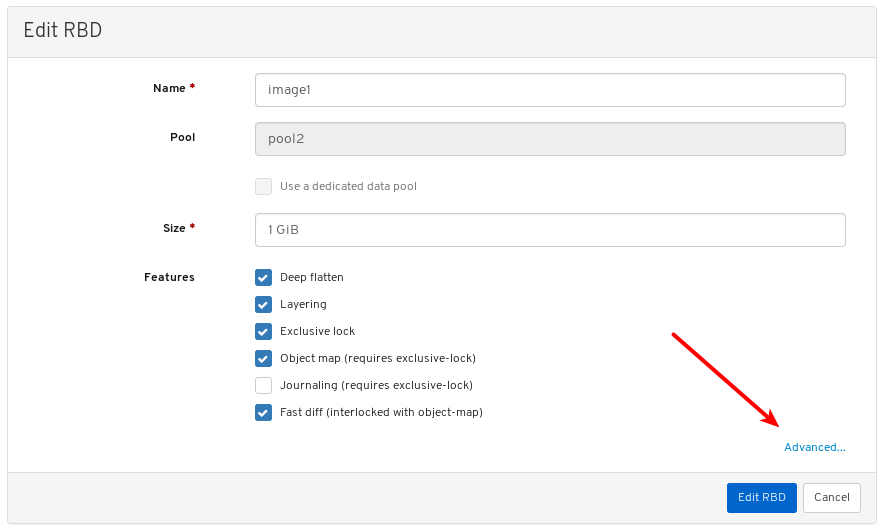

手順

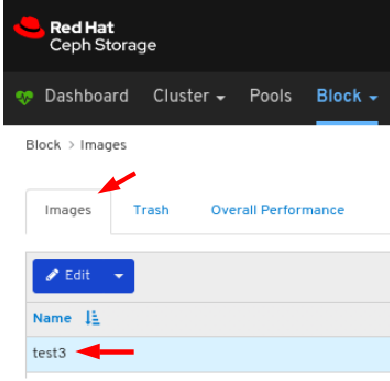

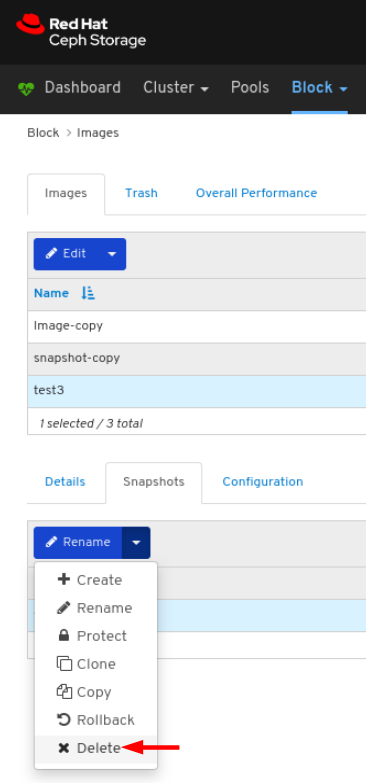

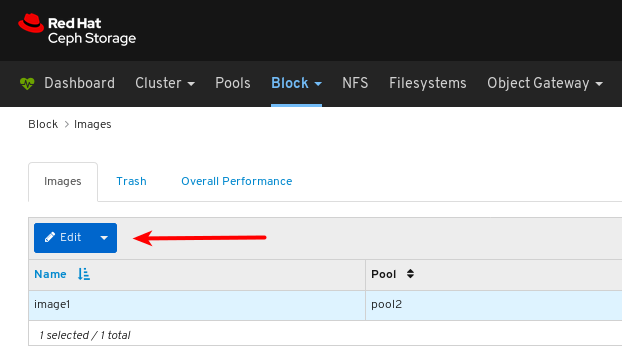

- ダッシュボードにログインします。

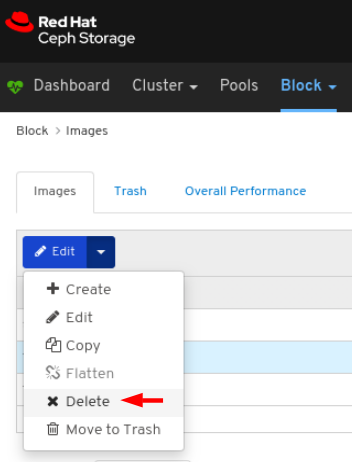

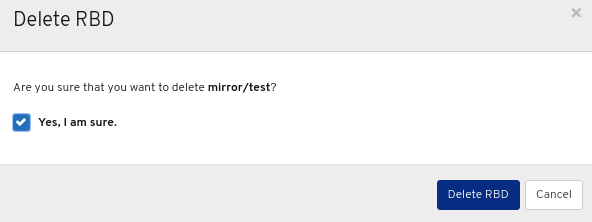

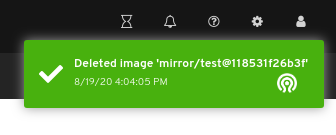

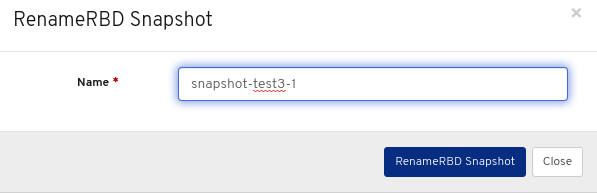

ナビゲーションバーで、Block をクリックします。

ドロップダウンから Images を選択します。

イメージを編集するには、Images タブでその行をクリックします。

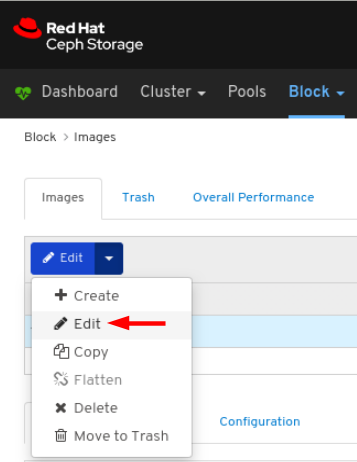

Edit ドロップダウンメニューで Edit を選択します。

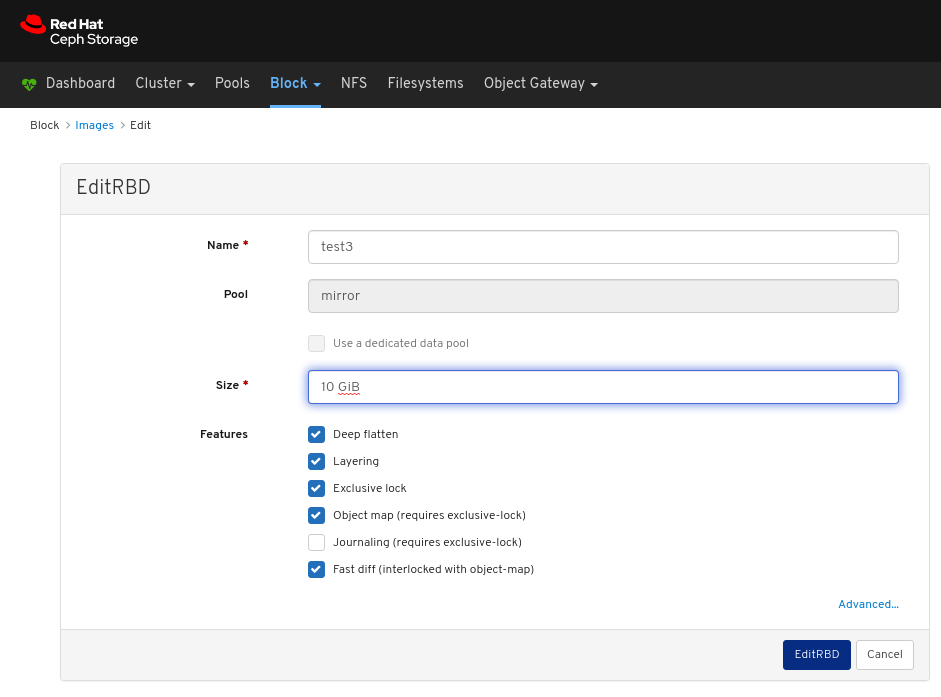

EditRBD ダイアログで、必要なパラメーターを編集して、EditRBD ボタンをクリックします。

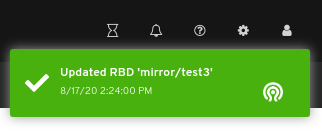

ページの右上隅に対する通知は、イメージが正常に更新されたことを示しています。

関連情報

- 詳細は、Red Hat Ceph Storage ダッシュボードガイドの イメージの作成 セクションを参照してください。

9.2.5. イメージのコピー

ダッシュボードでは、イメージをコピーできます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- rbd アプリケーションが有効になっているプールが作成されている。

- イメージが作成されている。

手順

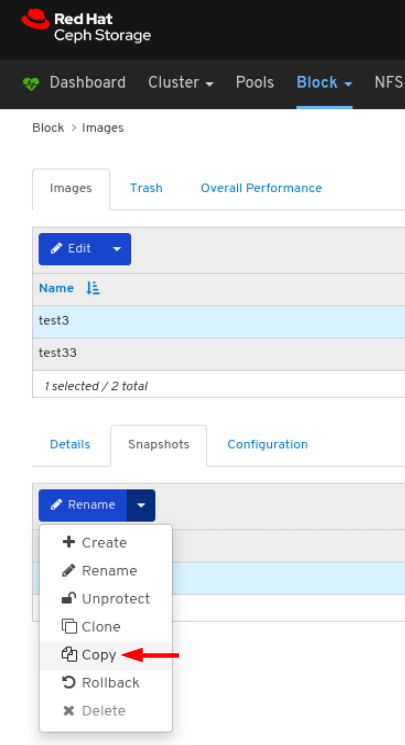

- ダッシュボードにログインします。

ナビゲーションバーで、Block をクリックします。

ドロップダウンから Images を選択します。

イメージをコピーするには、Images タブでその行をクリックします。

Edit ドロップダウンの Copy を選択します。

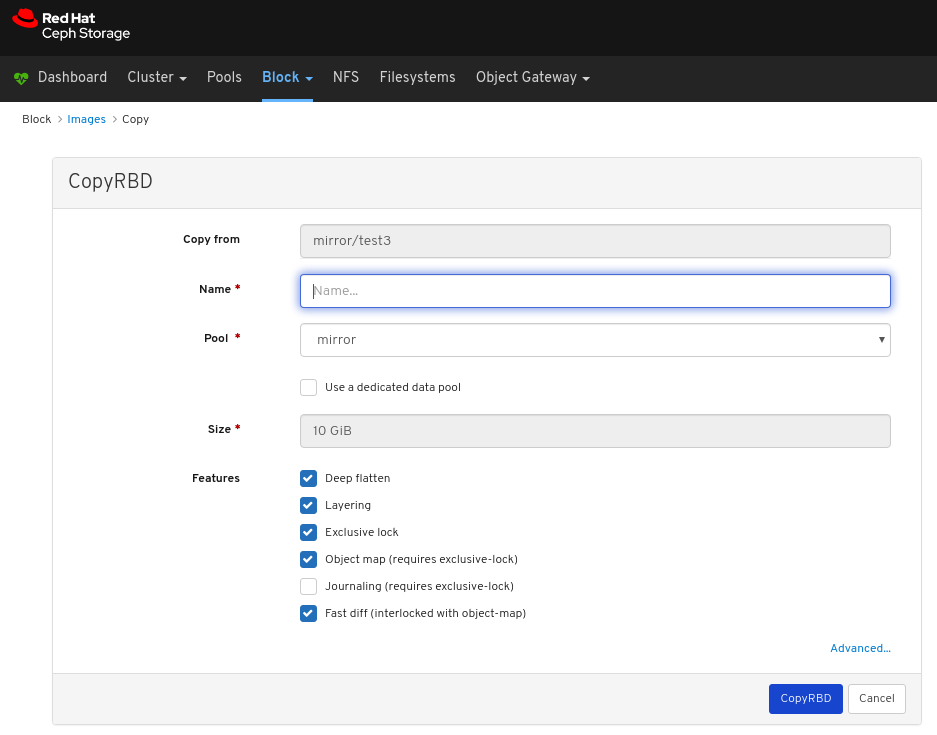

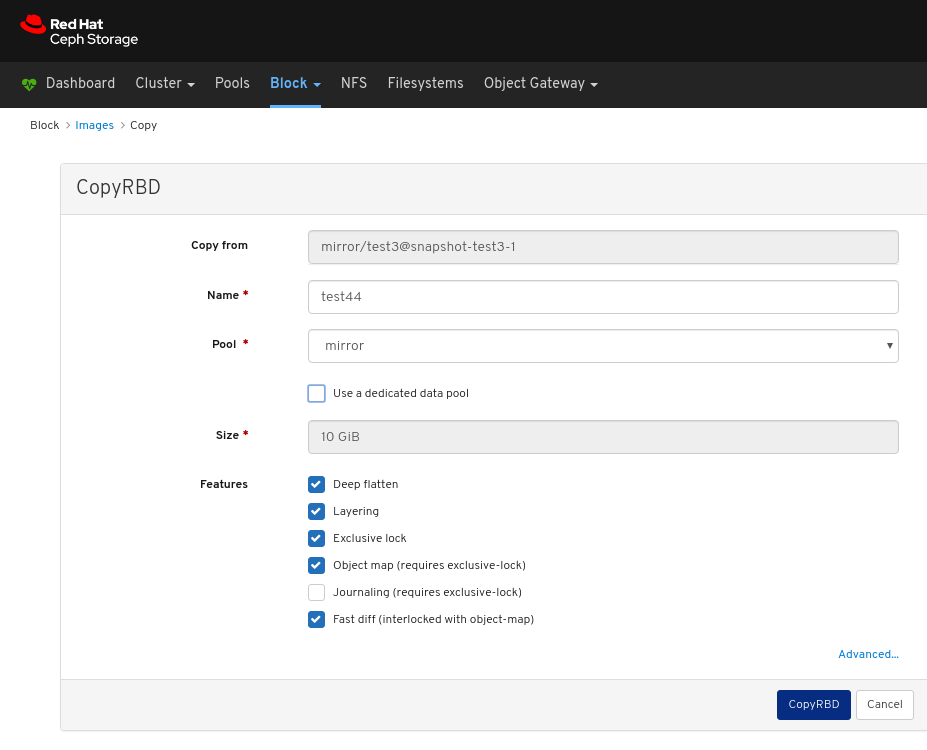

CopyRBD ウィンドウで必要なパラメーターを編集して、CopyRBD ボタンをクリックします。

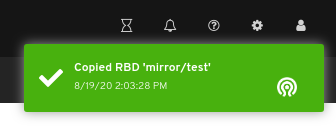

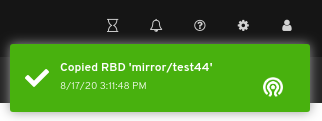

ページの右上隅に対する通知は、イメージが正常に更新されたことを示しています。

関連情報

- 詳細は、Red Hat Ceph Storage ダッシュボードガイドの イメージの作成 セクションを参照してください。

9.2.6. イメージのごみ箱への移動

ダッシュボードでは、イメージをごみ箱に移動できます。

前提条件

- Red Hat Ceph Storage クラスターが実行されている。

- Dashboard がインストールされている。

- rbd アプリケーションが有効になっているプールが作成されている。

- イメージが作成されている。

手順

- ダッシュボードにログインします。

ナビゲーションバーで、Block をクリックします。

ドロップダウンから Images を選択します。

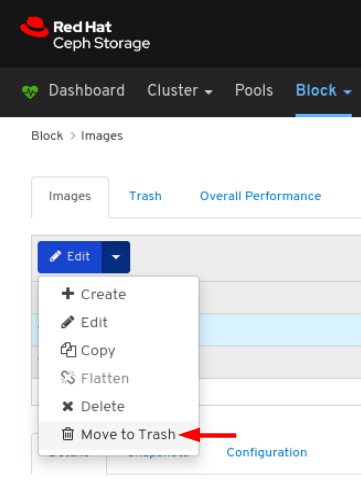

イメージをゴミ箱に移動するには、Images タブでその行をクリックします。

Edit ドロップダウンメニューで Move to Trash を選択します。

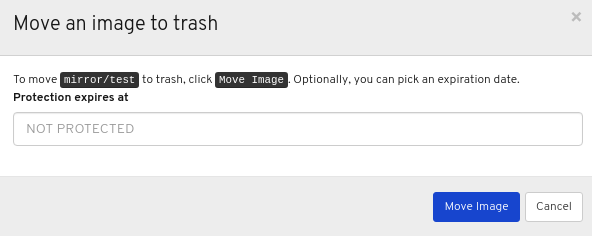

Moving an image to trash ウィンドウで、イメージが保護する必要のある日付を編集し、Move Image ボタンをクリックします。

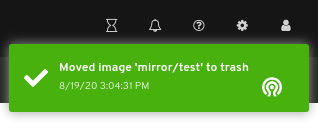

ページの右上隅に対する通知では、イメージが正常にごみ箱に移動したことが分かります。

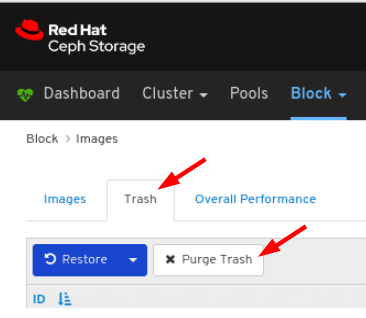

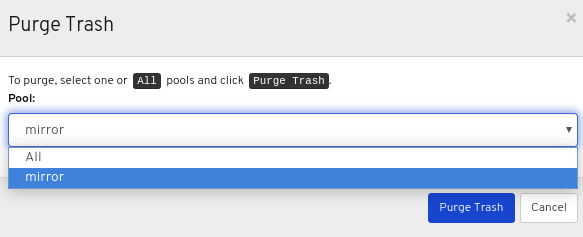

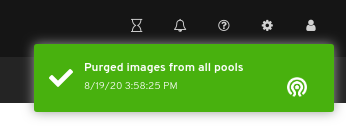

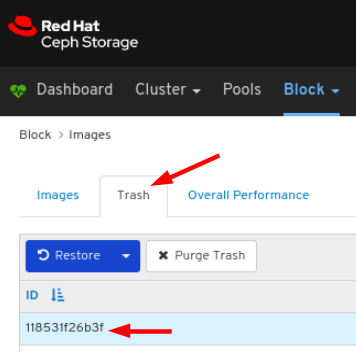

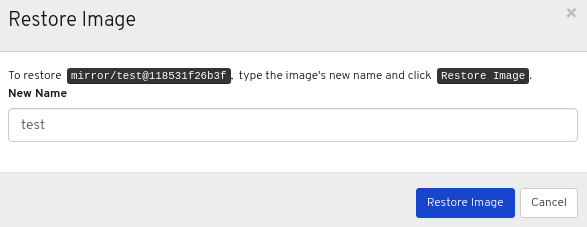

9.2.7. ごみ箱のパージ

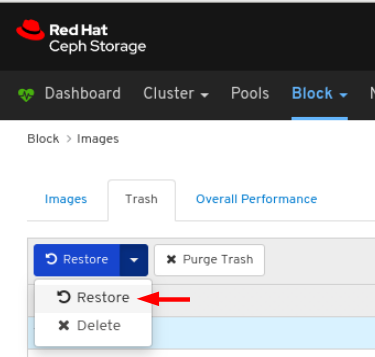

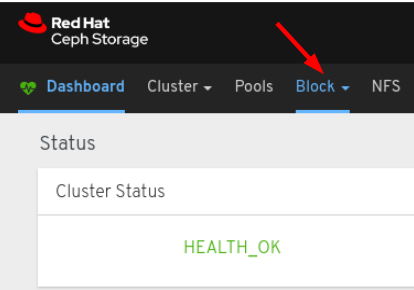

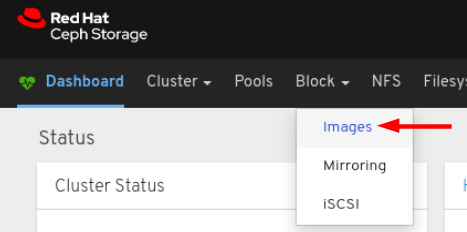

ダッシュボードでは、イメージのごみ箱をパージすることができます。