インストールガイド

Red Hat Enterprise Linux への Red Hat Ceph Storage のインストール

概要

第1章 Red Hat Ceph Storage とは

Red Hat Ceph Storage は、スケーラブルでオープンなソフトウェア定義のストレージプラットフォームであり、エンタープライズ向けバージョンの Ceph ストレージシステムと Ceph 管理プラットフォーム、デプロイメントユーティリティー、およびサポートサービスを組み合わせたものです。Red Hat Ceph Storage は、クラウドインフラストラクチャーおよび Web スケールオブジェクトストレージ用に設計されています。Red Hat Ceph Storage クラスターは、以下のタイプのノードで設定されます。

Red Hat Ceph Storage Ansible 管理

Ansible 管理ノードは、以前のバージョンの Red Hat Ceph Storage で使用されていた従来の Ceph 管理ノードとして機能します。Ansible の管理ノードには、以下の機能があります。

- 集中ストレージクラスター管理。

- Ceph 設定ファイルおよびキー。

- 必要に応じて、セキュリティー上の理由からインターネットにアクセスできないノードに Ceph をインストールするためのローカルリポジトリー。

Ceph Monitor

各 Ceph Monitor ノードは ceph-mon デーモンを実行し、ストレージクラスターマップのマスターコピーを維持します。ストレージクラスターマップには、ストレージクラスタートポロジーが含まれます。Ceph ストレージクラスターに接続するクライアントは、Ceph Monitor からストレージクラスターマッピングの現在のコピーを取得します。これにより、クライアントはストレージクラスターからデータの読み取りおよび書き込みが可能になります。

ストレージクラスターは、1 つの Ceph Monitor でのみ実行できます。ただし、実稼働環境のストレージクラスターで高可用性を確保するために、RedHat は少なくとも 3 つの Ceph Monitor ノードを使用したデプロイメントのみをサポートします。Red Hat は、750 Ceph OSD を超えるストレージクラスター用に合計 5 つの Ceph Monitor をデプロイすることを推奨します。

Ceph OSD

各 Ceph Object Storage Device(OSD) ノードは ceph-osd デーモンを実行し、ノードに接続されている論理ディスクと対話します。ストレージクラスターは、データをこれらの Ceph OSD ノードに保存します。

Ceph は、OSD ノードを非常に少ない状態で実行できます (デフォルトは 3 つですが、実稼働ストレージクラスターは適度な規模から初めてより良いパフォーマンスが向上します)。たとえば、ストレージクラスター内の 50 の Ceph OSD など。理想的には、Ceph Storage クラスターには複数の OSD ノードがあり、CRUSH マップを適宜設定して障害のドメインを分離できることが望ましいと言えます。

Ceph MDS

各 Ceph Metadata Server (MDS) ノードは ceph-mds デーモンを実行し、Ceph File System (CephFS) に保管されたファイルに関するメタデータを管理します。Ceph MDS デーモンは、共有ストレージクラスターへのアクセスも調整します。

Ceph Object Gateway

Ceph Object Gateway ノードは ceph-radosgw デーモンを実行し、librados 上に構築されたオブジェクトストレージインターフェイスで、アプリケーションに Ceph ストレージクラスターへの RESTful アクセスポイントを提供します。Ceph Object Gateway は以下の 2 つのインターフェイスをサポートします。

S3

Amazon S3 RESTful API の大規模なサブセットと互換性のあるインターフェイスでオブジェクトストレージ機能を提供します。

Swift

OpenStack Swift API の大規模なサブセットと互換性のあるインターフェイスでオブジェクトストレージ機能を提供します。

関連情報

- Ceph アーキテクチャーの詳細は、Red Hat Ceph ストレージ管理ガイド を参照してください。

- ハードウェアの最小推奨事項は、Red Hat Ceph Storage ハードウェア選択ガイド を参照してください。

第2章 Red Hat Ceph Storage に関する考慮事項および推奨事項

ストレージ管理者は、Red Hat Ceph Storage クラスターを実行する前に考慮すべき内容を基本的に理解しておくようにしてください。ハードウェアおよびネットワークの要件、Red Hat Ceph Storage クラスターと適切に機能するワークロードのタイプや Red Hat の推奨事項を確認してください。Red Hat Ceph Storage は、特定のビジネスニーズまたは要件に基づいて異なるワークロードに使用できます。Red Hat Ceph Storage をインストールする前に、Ceph ストレージクラスターを効率的に実行するには、ビジネス要件を達成するのに必要な計画を立てます。

特定のユースケースで Red Hat Ceph Storage クラスターの使用計画にサポートが必要ですか ?レッドハットの担当者にご相談ください。

2.1. 前提条件

- ストレージソリューションを理解、検討、計画する時間を確保する。

2.2. Red Hat Ceph Storage の基本的な考慮事項

Red Hat Ceph Storage を使用するための最初の考慮事項は、データのストレージストラテジーの開発についてです。ストレージストラテジーとは、特定のユースケースに対応するためのデータを保管する手法を指します。OpenStack などのクラウドプラットフォームのボリュームおよびイメージを保存する必要がある場合は、ジャーナル用に Solid State Drives(SSD) を使用する高速な Serial Attached SCSI(SAS) ドライブにデータを保存することができます。一方、S3 または Swift 準拠のゲートウェイのオブジェクトデータを保存する必要がある場合は、従来の Serial Advanced Technology Attachment(SATA) ドライブなど、より経済的な方法を使用できます。Red Hat Ceph Storage は、同じストレージクラスターの両方のシナリオに対応しますが、クラウドプラットフォーム用に高速ストレージストラテジーと、オブジェクトストア用に従来のストレージを提供する手段が必要です。

Ceph のデプロイメントを正常に実行するための最も重要な手順の 1 つとして、クラスターのユースケースとワークロードに適した価格性能比のプロファイルを特定します。ユースケースに適したハードウェアを選択することが重要です。たとえば、コールドストレージアプリケーション用に IOPS が最適化されたハードウェアを選択すると、ハードウェアのコストが必要以上に増加します。また、IOPS が重視されるワークロードにおいて、より魅力的な価格帯に対して容量が最適化されたハードウェアを選択すると、パフォーマンスの低下に不満を持つユーザーが出てくる可能性が高くなります。

Red Hat Ceph Storage は、複数のストレージストラテジーをサポートできます。健全なストレージ戦略を策定するには、ユースケース、費用対効果、パフォーマンスのトレードオフ、データの耐久性などを考慮する必要があります。

ユースケース

Ceph は大容量のストレージを提供し、多くのユースケースをサポートします。

- Ceph Block Device クライアントは、クラウドプラットフォーム向けの代表的なストレージバックエンドで、ボリュームやイメージに対して制限なくストレージを提供し、コピーオンライトクローニングなど、高パフォーマンス機能を備えています。

- Ceph Object Gateway クライアントは、音声、ビットマップ、ビデオなどのオブジェクト向けの RESTful S3 準拠のオブジェクトおよび Swift 準拠のオブジェクトストレージを提供するクラウドプラットフォームの主要なストレージバックエンドです。

- 従来のファイルストレージである Ceph ファイルシステム。

コスト vs.パフォーマンス

速度、サイズ、耐久性など高いほうが優れています。ただし、優れた品質にはそれぞれコストがかかるので、費用対効果の面でトレードオフがあります。パフォーマンスの観点からでは、以下のユースケースを考慮してください。SSD は、比較的小規模なデータおよびジャーナリングのために非常に高速ストレージを提供できます。データベースやオブジェクトインデックスの保存には、非常に高速な SSD のプールが有効ですが、他のデータの保存にはコストがかかりすぎてしまいます。SSD ジャーナリングのある SAS ドライブは、ボリュームやイメージを安価かつ高速なパフォーマンスで提供できます。SSD ジャーナリングのない SATA ドライブは、全体的なパフォーマンスは低くなりますが、ストレージの価格を安価に抑えることができます。OSD の CRUSH 階層を作成する場合は、ユースケースと許容コスト/パフォーマンスのトレードオフを考慮する必要があります。

データの持続性

大規模なクラスターでは、ハードウェア障害は想定されており、例外ではありません。ただし依然として、データの損失および中断は受け入れられません。そのため、データの持続性は非常に重要になります。Ceph は、オブジェクトの複数のレプリカコピー、またはイレイジャーコーディングおよび複数のコーディングのチャンクでデータの持続性に対応します。複数のコピーまたはコーディングチャンクにより、さらに費用対効果の面でのトレードオフが分かります。コピーやコーディングのチャンクが少ない場合にはコストがかかりませんが、パフォーマンスが低下した状態で、書き込み要求に対応できなくなる可能性があります。通常、追加のコピーまたはコーディングチャンクが 2 つあるオブジェクトを使用すると、ストレージクラスターが復旧する間に、パフォーマンスが低下した状態でクラスターの書き込みを行うことができます。

レプリケーションでは、ハードウェア障害に備えて、障害ドメインをまたいで 1 つ以上のデータの冗長コピーを保存します。しかし、データの冗長コピーは、規模が大きくなるとコスト高になります。たとえば、1 ペタバイトのデータを 3 つのレプリケーションで保存するには、少なくとも容量が 3 ペタバイトあるストレージクラスターが必要になります。

イレイジャーコーディングでは、データをデータチャンクとコーディングチャンクに分けて保存します。データチャンクが失われた場合には、イレイジャーコーディングにより、残りのデータチャンクとコーディングチャンクで失われたデータチャンクを回復できます。イレイジャーコーディングはレプリケーションに比べて大幅に経済的です。たとえば、データチャンク 8 つとコーディングチャンク 3 つのイレイジャーコーディングを使用すると、データのコピーが 3 つある状態と同じ冗長性が得られます。ただし、このようなエンコーディングスキームでは、初期のデータ保存量が約 1.5 倍になるのに対し、レプリケーションでは 3 倍になります。

CRUSH アルゴリズムは、Ceph が、ストレージクラスター内の異なる場所に追加のコピーまたはコーディングチャンクを保存して、このプロセスをサポートします。これにより、1 つのストレージデバイスまたはノードに障害が発生しても、データ損失を回避するために必要なコピーやコーディングチャンクがすべて失われないようにします。費用対効果の面でのトレードオフやデータの耐性を考慮してストレージ戦略を計画し、ストレージプールとして Ceph クライアントに提示します。

データストレージプールのみがイレイジャーコーディングを使用できます。サービスデータやバケットインデックスを格納するプールはレプリケーションを使用します。

Ceph のオブジェクトコピーやコーディングチャンクを使用すると、RAID ソリューションが古く感じられます。Ceph はすでにデータの持続性に対応しており、質の低い RAID ではパフォーマンスに悪影響があり、RAID を使用してデータを復元すると、ディープコピーや消失訂正を使用するよりもはるかにスピードが遅くなるので、RAID は使用しないでください。

2.3. Red Hat Ceph Storage ワークロードに関する考慮事項

Ceph Storage クラスターの主な利点の 1 つとして、パフォーマンスドメインを使用して、同じストレージクラスター内のさまざまなタイプのワークロードをサポートする機能があります。各パフォーマンスドメインには、異なるハードウェア設定を関連付けることができます。ストレージ管理者は、ストレージプールを適切なパフォーマンスドメインに配置し、特定のパフォーマンスとコストプロファイルに合わせたストレージをアプリケーションに提供できます。これらのパフォーマンスドメインに適切なサイズ設定と最適化されたサーバーを選択することは、Red Hat Ceph Storage クラスターを設計するのに不可欠な要素です。

データの読み取りおよび書き込みを行う Ceph クライアントインターフェイスに対して、Ceph Storage クラスターはクライアントがデータを格納する単純なプールとして表示されます。ただし、ストレージクラスターは、クライアントインターフェイスから完全に透過的な方法で多くの複雑な操作を実行します。Ceph クライアントおよび Ceph オブジェクトストレージデーモン (Ceph OSD または単に OSD) はいずれも、オブジェクトのストレージおよび取得にスケーラブルなハッシュ (CRUSH) アルゴリズムで制御されたレプリケーションを使用します。Ceph OSD は、コンテナーまたは RPM ベースのデプロイメントを使用して、ストレージクラスター内のベアメタルサーバーまたは仮想マシンで実行できます。

CRUSH マップはクラスターリソースのトポロジーを表し、マップは、クラスター内のクライアントノードと Ceph Monitor ノードの両方に存在します。Ceph クライアントおよび Ceph OSD はどちらも CRUSH マップと CRUSH アルゴリズムを使用します。Ceph クライアントは OSD と直接通信することで、オブジェクト検索の集中化とパフォーマンスのボトルネックとなる可能性を排除します。CRUSH マップとピアとの通信を認識することで、OSD は動的障害復旧のレプリケーション、バックフィル、およびリカバリーを処理できます。

Ceph は CRUSH マップを使用して障害ドメインを実装します。Ceph は CRUSH マップを使用してパフォーマンスドメインの実装も行います。パフォーマンスドメインは、基礎となるハードウェアのパフォーマンスプロファイルを反映させます。CRUSH マップは Ceph のデータの格納方法を記述し、これは単純な階層 (例: 非周期グラフ) およびルールセットとして実装されます。CRUSH マップは複数の階層をサポートし、ハードウェアパフォーマンスプロファイルのタイプを別のタイプから分離できます。Ceph では、デバイスの classes でパフォーマンスドメインを実装しています。

たとえば、これらのパフォーマンスドメインを同じ Red Hat Ceph Storage クラスター内に共存させることができます。

- ハードディスクドライブ (HDD) は、一般的にコストと容量を重視したワークロードに適しています。

- スループットを区別するワークロードは通常、ソリッドステートドライブ (SSD) の Ceph 書き込みジャーナルで HDD を使用します。

- MySQL や MariaDB のような IOPS を多用するワークロードでは、SSD を使用することが多いです。

ワークロード

Red Hat Ceph Storage は、3 つの主要なワークロードに最適化されています。

IOPS を最適化: IOPS (Input, Output per Second) が最適化されたデプロイメントは、MYSQL や MariaDB インスタンスを OpenStack 上の仮想マシンとして稼働させるなど、クラウドコンピューティングの操作に適しています。IOPS が最適化された導入では、15k RPM の SAS ドライブや、頻繁な書き込み操作を処理するための個別の SSD ジャーナルなど、より高性能なストレージが必要となります。一部の IOPS のシナリオでは、すべてのフラッシュストレージを使用して IOPS と総スループットが向上します。

IOPS が最適化されたストレージクラスターには、以下のプロパティーがあります。

- IOPS あたり最小コスト

- 1 GB あたりの最大 IOPS。

- 99 パーセンタイルのレイテンシーの一貫性。

IOPS に最適化されたストレージクラスターの用途は以下のとおりです。

- 典型的なブロックストレージ。

- ハードドライブ (HDD) の 3x レプリケーションまたはソリッドステートドライブ (SSD) の 2x レプリケーション。

- OpenStack クラウド上の MySQL

最適化されたスループット: スループットが最適化されたデプロイメントは、グラフィック、音声、ビデオコンテンツなどの大量のデータを提供するのに適しています。スループットが最適化されたデプロイメントには、高帯域幅のネットワークハードウェア、コントローラー、高速シーケンシャル読み取り/書き込み機能のあるハードディスクドライブが必要です。高速なデータアクセスが必要な場合は、スループットを最適化したストレージ戦略を使用します。また、高速な書き込み性能が必要な場合は、ジャーナルに SSD (Solid State Disks) を使用すると、書き込み性能が大幅に向上します。

スループットが最適化されたストレージクラスターには、以下のような特性があります。

- MBps あたりの最小コスト (スループット)。

- TB あたり最も高い MBps。

- BTU あたりの最大 MBps

- Watt あたりの MBps の最大数。

- 97 パーセンタイルのレイテンシーの一貫性。

スループットを最適化したストレージクラスターの用途は以下のとおりです。

- ブロックまたはオブジェクトストレージ。

- 3x レプリケーション。

- ビデオ、音声、およびイメージのアクティブなパフォーマンスストレージ。

- 4K 映像などのストリーミングメディア

最適化された容量: 容量が最適化されたデプロイメントは、大量のデータを可能な限り安価に保存するのに適しています。容量が最適化されたデプロイメントは通常、パフォーマンスがより魅力的な価格と引き換えになります。たとえば、容量を最適化したデプロイメントでは、ジャーナリングに SSD を使用するのではなく、より低速で安価な SATA ドライブを使用し、ジャーナルを同じ場所に配置することがよくあります。

コストと容量が最適化されたストレージクラスターには、次のような特性があります。

- TB あたり最小コスト

- TB あたり最小の BTU 数。

- TB あたりに必要な最小 Watt。

コストと容量が最適化されたストレージクラスターの用途は以下のとおりです。

- 典型的なオブジェクトストレージ。

- 使用可能な容量を最大化するイレイジャーコーディング

- オブジェクトアーカイブ。

- ビデオ、音声、およびイメージオブジェクトのリポジトリー。

ストレージクラスターの価格とパフォーマンスに大きな影響を与えるので、どのハードウェアを購入するかを検討する前に、Red Hat Ceph Storage クラスターで実行するワークロードを慎重に検討してください。たとえば、ワークロードの容量が最適化されいるにも拘らず、スループットが最適化されたワークロードに、対象のハードウェアがより適している場合に、ハードウェアが必要以上に高価になってしまいます。逆に、ワークロードのスループットが最適化されていて、容量が最適化されたワークロードに、対象のハードウェアが適している場合は、ストレージクラスターのパフォーマンスが低下します。

2.4. Red Hat Ceph Storage のネットワークに関する考察

クラウドストレージソリューションの重要な点は、ネットワークのレイテンシーなどの要因により、ストレージクラスターが IOPS 不足になることです。また、ストレージクラスターがストレージ容量を使い果たす、はるか前に、帯域幅の制約が原因でスループットが不足することがあります。つまり、価格対性能の要求を満たすには、ネットワークのハードウェア設定が選択されたワークロードをサポートする必要があります。

ストレージ管理者は、ストレージクラスターをできるだけ早く復旧することを望みます。ストレージクラスターネットワークの帯域幅要件を慎重に検討し、ネットワークリンクのオーバーサブスクリプションに注意してください。また、クライアント間のトラフィックからクラスター内のトラフィックを分離します。また、SSD (Solid State Disk) やフラッシュ、NVMe などの高性能なストレージデバイスの使用を検討する場合には、ネットワークパフォーマンスの重要性が増していることも考慮してください。

Ceph はパブリックネットワークとストレージクラスターネットワークをサポートしています。パブリックネットワークは、クライアントのトラフィックと Ceph Monitor との通信を処理します。ストレージクラスターネットワークは、Ceph OSD のハートビート、レプリケーション、バックフィル、リカバリーのトラフィックを処理します。ストレージハードウェアには、最低でも 10GB のイーサネットリンクを 1 つ使用し、接続性とスループット向けにさらに 10GB イーサネットリンクを追加できます。

Red Hat では、レプリケートされたプールをもとに osd_pool_default_size を使用してパブリックネットワークの倍数となるように、ストレージクラスターネットワークに帯域幅を割り当てることを推奨しています。また、Red Hat はパブリックネットワークとストレージクラスターネットワークを別々のネットワークカードで実行することを推奨しています。

Red Hat では、実稼働環境での Red Hat Ceph Storage のデプロイメントに 10GB のイーサネットを使用することを推奨しています。1GB のイーサネットネットワークは、実稼働環境のストレージクラスターには適していません。

ドライブに障害が発生した場合、1 GB イーサネットネットワーク全体で 1 TB のデータをレプリケートするには 3 時間かかります。3 TB には 9 時間かかります。3TB を使用するのが一般的なドライブ設定です。一方、10GB のイーサネットネットワークの場合、レプリケーションにかかる時間はそれぞれ 20 分、1 時間となります。Ceph OSD に障害が発生した場合には、ストレージクラスターは、含まれるデータをプール内の他の Ceph OSD にレプリケートして復元することに注意してください。

ラックなどの大規模なドメインに障害が発生した場合は、ストレージクラスターが帯域幅を大幅に消費することになります。複数のラックで設定されるストレージクラスター (大規模なストレージ実装では一般的) を構築する際には、最適なパフォーマンスを得るために、ファットツリー設計でスイッチ間のネットワーク帯域幅をできるだけ多く利用することを検討してください。一般的な 10 GB のイーサネットスイッチには、48 個の 10 GB ポートと 4 個の 40 GB のポートがあります。スループットを最大にするには、Spine (背骨) で 40 GB ポートを使用します。または、QSFP+ および SFP+ ケーブルを使用する未使用の 10 GB ポートを別のラックおよびスパインルーターに接続するために、さらに 40 GB のポートに集計することを検討します。また、LACP モード 4 でネットワークインターフェイスを結合することも検討してください。また、特にバックエンドやクラスターのネットワークでは、ジャンボフレーム、最大伝送単位 (MTU) 9000 を使用してください。

Red Hat Ceph Storage クラスターをインストールしてテストする前に、ネットワークのスループットを確認します。Ceph のパフォーマンスに関する問題のほとんどは、ネットワークの問題から始まります。Cat-6 ケーブルのねじれや曲がりといった単純なネットワークの問題は、帯域幅の低下につながります。フロント側のネットワークには、最低でも 10 GB のイーサネットを使用してください。大規模なクラスターの場合には、バックエンドやクラスターのネットワークに 40GB のイーサネットを使用することを検討してください。

ネットワークの最適化には、CPU/帯域幅の比率を高めるためにジャンボフレームを使用し、非ブロックのネットワークスイッチのバックプレーンを使用することを Red Hat は推奨します。Red Hat Ceph Storage では、パブリックネットワークとクラスターネットワークの両方で、通信パスにあるすべてのネットワークデバイスに同じ MTU 値がエンドツーエンドで必要となります。Red Hat Ceph Storage クラスターを実稼働環境で使用する前に、環境内のすべてのノードとネットワーク機器で MTU 値が同じであることを確認します。

2.5. Ceph 実行時の Linux カーネルのチューニングに関する考察

実稼働環境用の Red Hat Ceph Storage クラスターでは、一般的にオペレーティングシステムのチューニング (特に制限とメモリー割り当て) が有効です。ストレージクラスター内の全ノードに調整が設定されていることを確認します。また、Red Hat サポートでケースを開き、追加でアドバイスを求めることもできます。

Ceph OSD 用の空きメモリーの確保

Ceph OSD のメモリー割り当て要求時にメモリー不足関連のエラーが発生しないように、予備として確保する物理メモリーの量を具体的に設定します。Red Hat では、システムメモリーの量に応じて以下の設定を推奨しています。

64 GB の場合は 1 GB を確保する。

vm.min_free_kbytes = 1048576

vm.min_free_kbytes = 1048576Copy to Clipboard Copied! Toggle word wrap Toggle overflow 128 GB の場合は 2 GB を確保する。

vm.min_free_kbytes = 2097152

vm.min_free_kbytes = 2097152Copy to Clipboard Copied! Toggle word wrap Toggle overflow 256 GB の場合は 3 GB を確保する。

vm.min_free_kbytes = 3145728

vm.min_free_kbytes = 3145728Copy to Clipboard Copied! Toggle word wrap Toggle overflow

ファイル記述子の増加

Ceph Object Gateway は、ファイル記述子が不足すると停止することがあります。Ceph Object Gateway ノードの /etc/security/limits.conf ファイルを変更して、Ceph Object Gateway のファイル記述子を増やすことができます。

ceph soft nofile unlimited

ceph soft nofile unlimited大規模ストレージクラスターの ulimit 値の調整

Ceph OSD が 1024 個以上あるなど、大規模なストレージクラスターで Ceph の管理コマンドを実行する場合は、管理コマンドを実行する各ノードに、次の内容の /etc/security/limits.d/50-ceph.conf ファイルを作成します。

USER_NAME soft nproc unlimited

USER_NAME soft nproc unlimitedUSER_NAME は、Ceph の管理コマンドを実行する root 以外のユーザーのアカウント名に置き換えます。

Red Hat Enterprise Linux では、root ユーザーの ulimit 値はすでにデフォルトで unlimited に設定されています。

2.6. OSD ノードで RAID コントローラーを使用する際の考慮事項

必要に応じて、OSD ノードで RAID コントローラーを使用することを検討してください。考慮すべき事項を以下に示します。

- OSD ノードに 1 ~ 2 GB のキャッシュがインストールされている RAID コントローラーがある場合は、ライトバックキャッシュを有効にすると、I/O 書き込みスループットが向上する可能性があります。ただし、キャッシュは不揮発性である必要があります。

- 最新の RAID コントローラーにはスーパーキャパシエーターがあり、電力損失イベント中に不揮発性 NAND メモリーに揮発性メモリーを流すのに十分な電力が提供されます。電源の復旧後に、特定のコントローラーとそのファームウェアがどのように動作するかを理解することが重要です。

- RAID コントローラーによっては、手動の介入が必要になります。ハードドライブは、ディスクキャッシュをデフォルトで有効または無効にすべきかどうかに関わらず、オペレーティングシステムにアドバタイズします。ただし、特定の RAID コントローラーとファームウェアは、このような情報を提供しません。ファイルシステムが破損しないように、ディスクレベルのキャッシュが無効になっていることを確認します。

- ライトバックキャッシュを有効にして、各 Ceph OSD データドライブにライトバックを設定して、単一の RAID 0 ボリュームを作成します。

- Serial Attached SCSI (SAS) または SATA 接続の Solid-state Drive (SSD) ディスクも RAID コントローラーに存在する場合は、コントローラーとファームウェアが pass-through モードをサポートしているかどうかを確認します。pass-through モードを有効にすると、キャッシュロジックが回避され、通常は高速メディアの待ち時間が大幅に低くなります。

2.7. Object Gateway で NVMe を使用する際の考慮事項

必要に応じて、Ceph Object Gateway に NVMe を使用することを検討してください。

Red Hat Ceph Storage のObject Gateway 機能を使用する予定で、OSD ノードが NVMe ベースの SSD を使用している場合は、実稼働向け Ceph Object Gateway の LVM での NVMe の最適な使用 に記載される手順に従ってください。これらの手順では、ジャーナルとバケットインデックスを SSD に一緒に配置する特別に設計された Ansible Playbook の使用方法を説明します。これにより、すべてのジャーナルを 1 つのデバイスに配置する場合に比べてパフォーマンスを向上させることができます。

2.8. Red Hat Ceph Storage の最小ハードウェア要件

Red Hat Ceph Storage は、プロプライエタリーではない、商用ハードウェアでも動作します。小規模な実稼働クラスターや開発クラスターは、適度なハードウェアで性能を最適化せずに動作させることができます。

Red Hat Ceph Storage は、デプロイメントがベアメタルであるか、コンテナー化されているかによって、要件が若干異なります。

ディスク領域の要件は、/var/lib/ceph/ ディレクトリー下の Ceph デーモンのデフォルトパスに基づいています。

| Process | 条件 | 最小推奨 |

|---|---|---|

|

| プロセッサー | 1x AMD64 または Intel 64 |

| RAM |

| |

| OS ディスク | ホストごとに 1x OS ディスク | |

| ボリュームストレージ | デーモンごとに 1x ストレージドライブ | |

|

|

任意ですが、Red Hat は、デーモンごとに 1x SSD、NVMe または Optane パーティション、または論理ボリューム 1 つを推奨します。サイズ設定は、オブジェクト、ファイルおよび混合ワークロード用に BlueStore に | |

|

|

任意、1x SSD、NVMe または Optane パーティション、またはデーモンごとに論理ボリューム。サイズが小さい (10 GB など) を使用し、 | |

| ネットワーク | 2x 10GB イーサネット NIC | |

|

| プロセッサー | 1x AMD64 または Intel 64 |

| RAM | デーモンごとに 1 GB | |

| ディスク容量 | デーモンごとに 15 GB | |

| 監視ディスク |

任意で、 | |

| ネットワーク | 2x 1 GB のイーサネット NIC | |

|

| プロセッサー | 1x AMD64 または Intel 64 |

| RAM | デーモンごとに 1 GB | |

| ネットワーク | 2x 1 GB のイーサネット NIC | |

|

| プロセッサー | 1x AMD64 または Intel 64 |

| RAM | デーモンごとに 1 GB | |

| ディスク容量 | デーモンごとに 5 GB | |

| ネットワーク | 1x 1 GB のイーサネット NIC | |

|

| プロセッサー | 1x AMD64 または Intel 64 |

| RAM | デーモンごとに 2 GB

この数は、設定可能な MDS キャッシュサイズに大きく依存します。通常、RAM 要件は、 | |

| ディスク容量 | デーモンごとに 2 MB、さらにロギングに必要な領域があり、設定されたログレベルに応じて異なる場合があります。 | |

| ネットワーク | 2x 1 GB のイーサネット NIC これは OSD と同じネットワークであることに注意してください。OSD で 10GB のネットワークを使用している場合は、MDS でも同じものを使用することで、レイテンシーの面で MDS が不利にならないようにする必要があります。 |

| Process | 条件 | 最小推奨 |

|---|---|---|

|

| プロセッサー | OSD コンテナーごとに 1x AMD64 または Intel 64 CPU CORE |

| RAM | 1 OSD コンテナーごとに最小 5 GB の RAM | |

| OS ディスク | ホストごとに 1x OS ディスク | |

| OSD ストレージ | OSD コンテナーごとに 1x ストレージドライブ。OS ディスクと共有できません。 | |

|

|

任意ですが、Red Hat は、デーモンごとに SSD、NVMe または Optane パーティション、または lvm を 1 つ推奨します。サイズ設定は、オブジェクト、ファイルおよび混合ワークロード用に BlueStore に | |

|

|

任意ですが、デーモンごとに 1x SSD、NVMe または Optane パーティション、または論理ボリューム。サイズが小さい (10 GB など) を使用し、 | |

| ネットワーク | 2x 10 GB のイーサネット NIC (10 GB の推奨) | |

|

| プロセッサー | mon-container ごとに 1x AMD64 または Intel 64 CPU CORE |

| RAM |

| |

| ディスク容量 |

| |

| 監視ディスク |

任意で、 | |

| ネットワーク | 2x 1 GB のイーサネット NIC (10 GB の推奨) | |

|

| プロセッサー |

|

| RAM |

| |

| ネットワーク | 2x 1 GB のイーサネット NIC (10 GB の推奨) | |

|

| プロセッサー | radosgw-container ごとに 1x AMD64 または Intel 64 CPU CORE |

| RAM | デーモンごとに 1 GB | |

| ディスク容量 | デーモンごとに 5 GB | |

| ネットワーク | 1x 1 GB のイーサネット NIC | |

|

| プロセッサー | mds-container ごとに 1x AMD64 または Intel 64 CPU CORE |

| RAM |

この数は、設定可能な MDS キャッシュサイズに大きく依存します。通常、RAM 要件は、 | |

| ディスク容量 |

| |

| ネットワーク | 2x 1 GB のイーサネット NIC (10 GB の推奨) これは、OSD コンテナーと同じネットワークであることに注意してください。OSD で 10GB のネットワークを使用している場合は、MDS でも同じものを使用することで、レイテンシーの面で MDS が不利にならないようにする必要があります。 |

第3章 Red Hat Ceph Storage のインストール要件

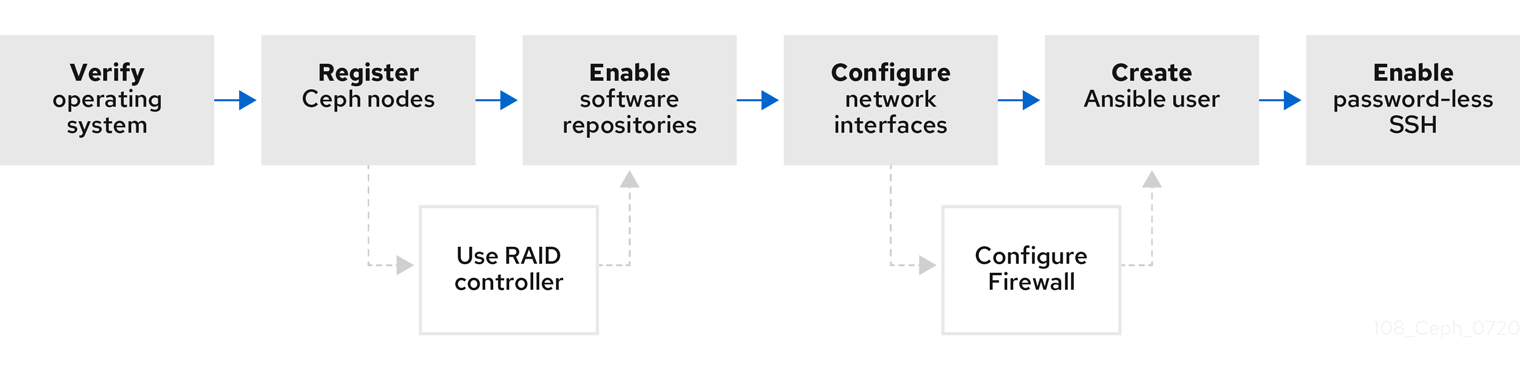

図3.1 前提条件のワークフロー

Red Hat Ceph Storage をインストールする前に、以下の要件をチェックして、各 Monitor、OSD、メタデータサーバー、およびクライアントノードを適宜準備します。

Red Hat Ceph Storage のリリースおよび対応する Red Hat Ceph Storage パッケージのバージョンは、Red Hat カスタマーポータルの What are the Red Hat Ceph Storage releases and corresponding Ceph package versions? を参照してください。

3.1. 前提条件

- ハードウェア が Red Hat Ceph Storage 4 の最小要件を満たしていることを確認します。

3.2. Red Hat Ceph Storage のインストールに関する要件チェックリスト

| タスク | 必須 | セクション | 推奨事項 |

|---|---|---|---|

| オペレーティングシステムのバージョンの確認 | はい | ||

| Ceph ノードの登録 | はい | ||

| Ceph ソフトウェアリポジトリーの有効化 | はい | ||

| OSD ノードでの RAID コントローラーの使用 | いいえ | RAID コントローラーでライトバックキャッシュを有効にすると、OSD ノードの小規模な I/O 書き込みスループットが増大する場合があります。 | |

| ネットワークの設定 | はい | 少なくとも、パブリックネットワークが必要です。ただし、クラスター通信用のプライベートネットワークが推奨されます。 | |

| ファイアウォールの設定 | いいえ | ファイアウォールは、ネットワークの信頼レベルを大きくすることができます。 | |

| Ansible ユーザーの作成 | はい | すべての Ceph ノードで Ansible ユーザーを作成する必要があります。 | |

| パスワードを使用しない SSH の有効化 | はい | Ansible で必須。 |

デフォルトでは、ceph-ansible は、NTP/chronyd を要件としてインストールします。NTP/chronyd がカスタマイズされている場合は、Red Hat Ceph Storage の手動インストール セクションのRed Hat Ceph Storage のネットワークタイムプロトコルの設定を参照して、Ceph で正しく機能するように NTP/chronyd を設定する方法を理解してください。

3.3. Red Hat Ceph Storage のオペレーティングシステム要件

Red Hat Enterprise Linux のエンタイトルメントは、Red Hat Ceph Storage のサブスクリプションに含まれます。

Red Hat Ceph Storage 4 の初期リリースは、Red Hat Enterprise Linux 7.7 または Red Hat Enterprise Linux 8.1 でサポートされています。現行バージョンの Red Hat Ceph Storage 4.3 は、Red Hat Enterprise Linux 7.9、8.4 EUS、8.5、および 8.6 でサポートされています。

Red Hat Ceph Storage 4 は、RPM ベースのデプロイメントまたはコンテナーベースのデプロイメントでサポートされます。

Red Hat Ceph Storage 4 を Red Hat Enterprise Linux 7 上に実行中のコンテナーにデプロイすると、Red Hat Enterprise Linux 8 コンテナーイメージで実行している Red Hat Ceph Storage 4 がデプロイされます。

すべてのノードで、同じオペレーティングシステムバージョン、アーキテクチャー、およびデプロイメントタイプを使用します。たとえば、AMD64 アーキテクチャーと Intel 64 アーキテクチャーの両方を備えたノードの混合、Red Hat Enterprise Linux 7 と Red Hat Enterprise Linux 8 オペレーティングシステムの両方を備えたノードの混合、RPM ベースのデプロイメントとコンテナーベースのデプロイメントの両方を備えたノードの混合は使用しないでください。

Red Hat は、異種アーキテクチャー、オペレーティングシステムバージョン、またはデプロイメントタイプを持つクラスターをサポートしません。

SELinux

デフォルトでは、SELinux は Enforcing モードに設定され、ceph-selinux パッケージがインストールされます。SELinux の詳細は、データのセキュリティーおよび強化機能ガイド、Red Hat Enterprise Linux 7 SELinux ユーザーおよび管理者のガイド、および Red Hat Enterprise Linux 8 SELinux の使用ガイド を参照してください。

関連情報

- Red Hat Enterprise Linux 8 用ドキュメントは、https://access.redhat.com/documentation/ja-jp/red_hat_enterprise_linux/8/ から入手できます。

- Red Hat Enterprise Linux 7 用ドキュメントは、https://access.redhat.com/documentation/ja-jp/red_hat_enterprise_linux/7/ から入手できます。

3.4. Red Hat Ceph Storage ノードの CDN への登録およびサブスクリプションの割り当て

各 Red Hat Ceph Storage ノードをコンテンツ配信ネットワーク (CDN) に登録し、ノードがソフトウェアリポジトリーにアクセスできるように適切なサブスクリプションを割り当てます。各 Red Hat Ceph Storage ノードは、完全な Red Hat Enterprise Linux 8 ベースコンテンツおよび extras リポジトリーコンテンツにアクセスできる必要があります。特に記述がない限り、ストレージクラスター内のベアメタルおよびコンテナーノードで以下の手順を実行します。

インストール時にインターネットにアクセスできないベアメタルの Red Hat Ceph Storage ノードの場合は、Red Hat Satellite サーバーを使用してソフトウェアコンテンツを提供します。ローカルの Red Hat Enterprise Linux 8 Server ISO イメージをマウントし、Red Hat Ceph Storage ノードを ISO イメージに指定します。詳細は、Red Hat サポート にお問い合わせください。

Red Hat Satellite サーバーに Ceph ノードの登録に関する詳細は、Red Hat カスタマーポータルの記事 How to Register Ceph with Satellite 6 および How to Register Ceph with Satellite 5 を参照してください。

前提条件

- 有効な Red Hat サブスクリプション

- Red Hat Ceph Storage ノードはインターネットに接続できるようにする必要があります。

- Red Hat Ceph Storage ノードへの root レベルのアクセス。

手順

コンテナー デプロイメントの場合には、Red Hat Ceph Storage ノードがデプロイ中にインターネットにアクセス できない 場合に限ります。最初に、インターネットアクセスのあるノードで、以下の手順を実行する必要があります。

ローカルのコンテナーレジストリーを起動します。

Red Hat Enterprise Linux 7

docker run -d -p 5000:5000 --restart=always --name registry registry:2

# docker run -d -p 5000:5000 --restart=always --name registry registry:2Copy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 8

podman run -d -p 5000:5000 --restart=always --name registry registry:2

# podman run -d -p 5000:5000 --restart=always --name registry registry:2Copy to Clipboard Copied! Toggle word wrap Toggle overflow registry.redhat.ioがコンテナーレジストリーの検索パスにあることを確認します。編集するために、

/etc/containers/registries.confファイルを開きます。[registries.search] registries = [ 'registry.access.redhat.com', 'registry.fedoraproject.org', 'registry.centos.org', 'docker.io']

[registries.search] registries = [ 'registry.access.redhat.com', 'registry.fedoraproject.org', 'registry.centos.org', 'docker.io']Copy to Clipboard Copied! Toggle word wrap Toggle overflow registry.redhat.ioがファイルに含まれていない場合は、これを追加します。[registries.search] registries = ['registry.redhat.io', 'registry.access.redhat.com', 'registry.fedoraproject.org', 'registry.centos.org', 'docker.io']

[registries.search] registries = ['registry.redhat.io', 'registry.access.redhat.com', 'registry.fedoraproject.org', 'registry.centos.org', 'docker.io']Copy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat カスタマーポータルから Red Hat Ceph Storage 4 イメージ、Prometheus イメージ、およびダッシュボードイメージをプルします。

Red Hat Enterprise Linux 7

docker pull registry.redhat.io/rhceph/rhceph-4-rhel8:latest docker pull registry.redhat.io/openshift4/ose-prometheus-node-exporter:v4.6 docker pull registry.redhat.io/rhceph/rhceph-4-dashboard-rhel8:latest docker pull registry.redhat.io/openshift4/ose-prometheus:v4.6 docker pull registry.redhat.io/openshift4/ose-prometheus-alertmanager:v4.6

# docker pull registry.redhat.io/rhceph/rhceph-4-rhel8:latest # docker pull registry.redhat.io/openshift4/ose-prometheus-node-exporter:v4.6 # docker pull registry.redhat.io/rhceph/rhceph-4-dashboard-rhel8:latest # docker pull registry.redhat.io/openshift4/ose-prometheus:v4.6 # docker pull registry.redhat.io/openshift4/ose-prometheus-alertmanager:v4.6Copy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 8

podman pull registry.redhat.io/rhceph/rhceph-4-rhel8:latest podman pull registry.redhat.io/openshift4/ose-prometheus-node-exporter:v4.6 podman pull registry.redhat.io/rhceph/rhceph-4-dashboard-rhel8:latest podman pull registry.redhat.io/openshift4/ose-prometheus:v4.6 podman pull registry.redhat.io/openshift4/ose-prometheus-alertmanager:v4.6

# podman pull registry.redhat.io/rhceph/rhceph-4-rhel8:latest # podman pull registry.redhat.io/openshift4/ose-prometheus-node-exporter:v4.6 # podman pull registry.redhat.io/rhceph/rhceph-4-dashboard-rhel8:latest # podman pull registry.redhat.io/openshift4/ose-prometheus:v4.6 # podman pull registry.redhat.io/openshift4/ose-prometheus-alertmanager:v4.6Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記Red Hat Enterprise Linux 7 および 8 はいずれも、Red Hat Enterprise Linux 8 をベースとした同じコンテナーイメージを使用します。

イメージにタグを付けます。

Prometheus のイメージタグのバージョンは、Red Hat Ceph Storage 4.2 の場合は v4.6 です。

Red Hat Enterprise Linux 7

docker tag registry.redhat.io/rhceph/rhceph-4-rhel8:latest LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-rhel8:latest # docker tag registry.redhat.io/openshift4/ose-prometheus-node-exporter:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-node-exporter:v4.6 # docker tag registry.redhat.io/rhceph/rhceph-4-dashboard-rhel8:latest LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-dashboard-rhel8:latest # docker tag registry.redhat.io/openshift4/ose-prometheus-alertmanager:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-alertmanager:v4.6 # docker tag registry.redhat.io/openshift4/ose-prometheus:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus:v4.6

# docker tag registry.redhat.io/rhceph/rhceph-4-rhel8:latest LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-rhel8:latest # docker tag registry.redhat.io/openshift4/ose-prometheus-node-exporter:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-node-exporter:v4.6 # docker tag registry.redhat.io/rhceph/rhceph-4-dashboard-rhel8:latest LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-dashboard-rhel8:latest # docker tag registry.redhat.io/openshift4/ose-prometheus-alertmanager:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-alertmanager:v4.6 # docker tag registry.redhat.io/openshift4/ose-prometheus:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus:v4.6Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 置き換え

- LOCAL_NODE_FQDN を、ローカルホストの FQDN に置き換えます。

Red Hat Enterprise Linux 8

podman tag registry.redhat.io/rhceph/rhceph-4-rhel8:latest LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-rhel8:latest # podman tag registry.redhat.io/openshift4/ose-prometheus-node-exporter:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-node-exporter:v4.6 # podman tag registry.redhat.io/rhceph/rhceph-4-dashboard-rhel8:latest LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-dashboard-rhel8:latest # podman tag registry.redhat.io/openshift4/ose-prometheus-alertmanager:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-alertmanager:v4.6 # podman tag registry.redhat.io/openshift4/ose-prometheus:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus:v4.6

# podman tag registry.redhat.io/rhceph/rhceph-4-rhel8:latest LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-rhel8:latest # podman tag registry.redhat.io/openshift4/ose-prometheus-node-exporter:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-node-exporter:v4.6 # podman tag registry.redhat.io/rhceph/rhceph-4-dashboard-rhel8:latest LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-dashboard-rhel8:latest # podman tag registry.redhat.io/openshift4/ose-prometheus-alertmanager:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-alertmanager:v4.6 # podman tag registry.redhat.io/openshift4/ose-prometheus:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus:v4.6Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 置き換え

- LOCAL_NODE_FQDN を、ローカルホストの FQDN に置き換えます。

etc/containers/registries.confファイルを編集し、ファイルに、ノードの FQDN とポートを追加し、保存します。[registries.insecure] registries = ['LOCAL_NODE_FQDN:5000']

[registries.insecure] registries = ['LOCAL_NODE_FQDN:5000']Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記この手順は、ローカルの Docker レジストリーにアクセスするすべてのストレージクラスターノードで行う必要があります。

イメージを、起動したローカルの Docker レジストリーにプッシュします。

Red Hat Enterprise Linux 7

docker push --remove-signatures LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-rhel8 # docker push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-node-exporter:v4.6 # docker push --remove-signatures LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-dashboard-rhel8 # docker push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-alertmanager:v4.6 # docker push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus:v4.6

# docker push --remove-signatures LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-rhel8 # docker push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-node-exporter:v4.6 # docker push --remove-signatures LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-dashboard-rhel8 # docker push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-alertmanager:v4.6 # docker push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus:v4.6Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 置き換え

- LOCAL_NODE_FQDN を、ローカルホストの FQDN に置き換えます。

Red Hat Enterprise Linux 8

podman push --remove-signatures LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-rhel8 # podman push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-node-exporter:v4.6 # podman push --remove-signatures LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-dashboard-rhel8 # podman push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-alertmanager:v4.6 # podman push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus:v4.6

# podman push --remove-signatures LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-rhel8 # podman push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-node-exporter:v4.6 # podman push --remove-signatures LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-dashboard-rhel8 # podman push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-alertmanager:v4.6 # podman push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus:v4.6Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 置き換え

- LOCAL_NODE_FQDN を、ローカルホストの FQDN に置き換えます。

Red Hat Enterprise Linux 7 では、

dockerサービスを再起動します。systemctl restart docker

# systemctl restart dockerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記デプロイメント中に RedHat Ceph Storage ノードがインターネットにアクセスできない場合の

all.ymlファイルの例は、Red Hat Ceph Storage クラスターのインストール インストールを参照してください。

すべてのデプロイメントで、ベアメタル または コンテナー の場合:

ノードを登録します。プロンプトが表示されたら、適切な Red Hat カスタマーポータルの認証情報を入力します。

subscription-manager register

# subscription-manager registerCopy to Clipboard Copied! Toggle word wrap Toggle overflow CDN から最新のサブスクリプションデータをプルします。

subscription-manager refresh

# subscription-manager refreshCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Ceph Storage で利用可能なサブスクリプションのリストを表示します。

subscription-manager list --available --all --matches="*Ceph*"

# subscription-manager list --available --all --matches="*Ceph*"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Ceph Storage の利用可能なサブスクリプションのリストから Pool ID をコピーします。

サブスクリプションを割り当てます。

subscription-manager attach --pool=POOL_ID

# subscription-manager attach --pool=POOL_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 置き換え

- POOL_ID を、直前の手順で特定したプール ID に置き換えます。

デフォルトのソフトウェアリポジトリーを無効にし、各バージョンの Red Hat Enterprise Linux でサーバーおよび追加のリポジトリーを有効にします。

Red Hat Enterprise Linux 7

subscription-manager repos --disable=* subscription-manager repos --enable=rhel-7-server-rpms subscription-manager repos --enable=rhel-7-server-extras-rpms

# subscription-manager repos --disable=* # subscription-manager repos --enable=rhel-7-server-rpms # subscription-manager repos --enable=rhel-7-server-extras-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 8

subscription-manager repos --disable=* subscription-manager repos --enable=rhel-8-for-x86_64-baseos-rpms subscription-manager repos --enable=rhel-8-for-x86_64-appstream-rpms

# subscription-manager repos --disable=* # subscription-manager repos --enable=rhel-8-for-x86_64-baseos-rpms # subscription-manager repos --enable=rhel-8-for-x86_64-appstream-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

システムを更新して、最新のパッケージを受け取ります。

Red Hat Enterprise Linux 7 の場合:

yum update

# yum updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 8 の場合:

dnf update

# dnf updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow

関連情報

- Red Hat Subscription Management の Subscription Manager の使用および設定 を参照してください。

- Red Hat Ceph Storage リポジトリーの有効化 を参照してください。

3.5. Red Hat Ceph Storage リポジトリーの有効化

Red Hat Ceph Storage をインストールする前に、インストール方法を選択する必要があります。Red Hat Ceph Storage では、以下の 2 つのインストール方法がサポートされます。

コンテンツ配信ネットワーク (CDN)

インターネットに直接接続可能な Ceph ノードを持つ Ceph Storage クラスターの場合は、Red Hat Subscription Manager を使用して必要な Ceph リポジトリーを有効にします。

ローカルリポジトリー

セキュリティー対策がインターネットにアクセスできない Ceph Storage クラスターでは、ISO イメージとして配信される単一のソフトウェアビルドから Red Hat Ceph Storage 4 をインストールします。これにより、ローカルリポジトリーをインストールできます。

前提条件

- 有効なカスタマーサブスクリプション

CDN インストールの場合:

- Red Hat Ceph Storage ノードはインターネットに接続できるようにする必要があります。

- クラスターノードを CDN に登録 します。

有効にする場合は、Exttra Packages for Enterprise Linux (EPEL) ソフトウェアリポジトリーを無効にします。

yum install yum-utils vim -y yum-config-manager --disable epel

[root@monitor ~]# yum install yum-utils vim -y [root@monitor ~]# yum-config-manager --disable epelCopy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

CDN インストールの場合:

Ansible 管理ノード で、Red Hat Ceph Storage 4 Tools リポジトリーおよび Ansible リポジトリーを有効にします。

Red Hat Enterprise Linux 7

subscription-manager repos --enable=rhel-7-server-rhceph-4-tools-rpms --enable=rhel-7-server-ansible-2.9-rpms

[root@admin ~]# subscription-manager repos --enable=rhel-7-server-rhceph-4-tools-rpms --enable=rhel-7-server-ansible-2.9-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 8

subscription-manager repos --enable=rhceph-4-tools-for-rhel-8-x86_64-rpms --enable=ansible-2.9-for-rhel-8-x86_64-rpms

[root@admin ~]# subscription-manager repos --enable=rhceph-4-tools-for-rhel-8-x86_64-rpms --enable=ansible-2.9-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow デフォルトでは、Red Hat Ceph Storage リポジトリーは対応するノードの

ceph-ansibleにより有効になります。リポジトリーを手動で有効にするには、以下を実行します。注記これらのリポジトリーは不要なため、コンテナー化されたデプロイメントでは有効にしないでください。

Ceph Monitor ノード で、Red Hat Ceph Storage 4 Monitor リポジトリーを有効にします。

Red Hat Enterprise Linux 7

subscription-manager repos --enable=rhel-7-server-rhceph-4-mon-rpms

[root@monitor ~]# subscription-manager repos --enable=rhel-7-server-rhceph-4-mon-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 8

subscription-manager repos --enable=rhceph-4-mon-for-rhel-8-x86_64-rpms

[root@monitor ~]# subscription-manager repos --enable=rhceph-4-mon-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph OSD ノード で、Red Hat Ceph Storage 4 OSD リポジトリーを有効にします。

Red Hat Enterprise Linux 7

subscription-manager repos --enable=rhel-7-server-rhceph-4-osd-rpms

[root@osd ~]# subscription-manager repos --enable=rhel-7-server-rhceph-4-osd-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 8

subscription-manager repos --enable=rhceph-4-osd-for-rhel-8-x86_64-rpms

[root@osd ~]# subscription-manager repos --enable=rhceph-4-osd-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow RBD ミラーリング、Ceph クライアント、Ceph Object Gateways、Metadata Servers、NFS、iSCSI ゲートウェイ、Dashboard サーバー などのノード種別で Red Hat Ceph Storage 4 Tools リポジトリーを有効にします。

Red Hat Enterprise Linux 7

subscription-manager repos --enable=rhel-7-server-rhceph-4-tools-rpms

[root@client ~]# subscription-manager repos --enable=rhel-7-server-rhceph-4-tools-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 8

subscription-manager repos --enable=rhceph-4-tools-for-rhel-8-x86_64-rpms

[root@client ~]# subscription-manager repos --enable=rhceph-4-tools-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow ISO インストールの場合:

- Red Hat カスタマーポータルにログインします。

- Downloads をクリックして、Software & Download センターに移動します。

- Red Hat Ceph Storage エリアで Download Software をクリックして、最新バージョンのソフトウェアをダウンロードします。

関連情報

- Red Hat Subscription Management 1 の Red Hat Subscription Manager の使用および設定 ガイド

3.6. Red Hat Ceph Storage のネットワーク設定の確認

すべての Red Hat Ceph Storage ノードにはパブリックネットワークが必要です。Ceph クライアントが Ceph monitor ノードおよび Ceph OSD ノードに到達できるパブリックネットワークにネットワークインターフェイスカードが設定されている必要があります。

Ceph がパブリックネットワークとは別のネットワークでハートビート、ピアリング、レプリケーション、および復元を実行できるように、クラスターネットワーク用のネットワークインターフェイスカードがある場合があります。

ネットワークインターフェイスを設定し、変更を永続化します。

Red Hat では、パブリックネットワークとプライベートネットワークの両方に単一のネットワークインターフェイスカードを使用することは推奨していません。

前提条件

- ネットワークに接続されたネットワークインターフェイスカード。

手順

ストレージクラスター内のすべての Red Hat Ceph Storage ノードで、root ユーザーとして以下の手順を実施します。

以下の設定が、公開されているネットワークインターフェイスカードに対応する

/etc/sysconfig/network-scripts/ifcfg-*ファイルにあることを確認します。-

静的 IP アドレスについて

BOOTPROTOパラメーターはnoneに設定されます。 ONBOOTパラメーターはyesに設定する必要があります。これが

noに設定されていると、Ceph ストレージクラスターがリブート時にピアに機能しなくなる可能性があります。IPv6 アドレス指定を使用する場合には、

IPV6_FAILURE_FATALパラメーターを除き、IPV6INITなどの IPV6 パラメーターをyesに設定する必要があります。また、Ceph 設定ファイル

/etc/ceph/ceph.confを編集して Ceph に IPv6 を使用するように指示します。指定しないと、Ceph は IPv4 を使用します。

-

静的 IP アドレスについて

関連情報

- Red Hat Enterprise Linux 8 用のネットワークインターフェイススクリプトの設定の詳細は、Red Hat Enterprise Linux 8 の ネットワークの設定および管理の ifcfg ファイルで IP ネットワークの設定 を参照してください。

- ネットワーク設定の詳細については、Red Hat Ceph Storage4 の 設定ガイド の Ceph ネットワーク設定 のセクションを参照してください。

3.7. Red Hat Ceph Storage のファイアウォールの設定

Red Hat CephStorage は、firewalld サービスを使用します。Firewalld サービスには、各デーモンのポートのリストが含まれています。

Ceph Monitor デーモンは、Ceph ストレージクラスター内の通信にポート 3300 および 6789 を使用します。

各 Ceph OSD ノードで、OSD デーモンは範囲 6800-7300 内の複数のポートを使用します。

- パブリックネットワークを介してクライアントおよびモニターと通信するための 1 つ

- クラスターネットワーク上で他の OSD にデータを送信する 1 つ (利用可能な場合)。それ以外の場合は、パブリックネットワーク経由でデータを送信します。

- 可能な場合は、クラスターネットワークを介してハートビートパケットを交換するための 1 つ。それ以外の場合は、パブリックネットワーク経由

Ceph Manager (ceph-mgr) デーモンは、6800-7300 範囲内のポートを使用します。同じノード上で Ceph Monitor と ceph-mgr デーモンを共存させることを検討してください。

Ceph Metadata Server ノード (ceph-mds) はポート範囲 6800-7300 を使用します。

Ceph Object Gateway ノードは、デフォルトで 8080 を使用するように Ansible によって設定されます。ただし、デフォルトのポート (例: ポート 80) を変更できます。

SSL/TLS サービスを使用するには、ポート 443 を開きます。

firewalld が有効な場合には、以下の手順は任意です。デフォルトでは、ceph-ansible には group_vars/all.yml に以下の設定が含まれ、これにより適切なポートが自動的に開きます。

configure_firewall: True

configure_firewall: True前提条件

- ネットワークハードウェアが接続されている。

-

ストレージクラスター内のすべてのノードへの

rootまたはsudoアクセスがある。

手順

ストレージクラスター内のすべてのノードで

firewalldサービスを起動します。これを有効にして、システムの起動時に実行し、実行していることを確認します。systemctl enable firewalld systemctl start firewalld systemctl status firewalld

# systemctl enable firewalld # systemctl start firewalld # systemctl status firewalldCopy to Clipboard Copied! Toggle word wrap Toggle overflow すべての Monitor ノードで、パブリックネットワークの

3300および6789ポートを開く。Copy to Clipboard Copied! Toggle word wrap Toggle overflow ソースアドレスに基づいてアクセスを制限するには、以下を実行します。

firewall-cmd --zone=public --add-rich-rule='rule family=ipv4 \ source address=IP_ADDRESS/NETMASK_PREFIX port protocol=tcp \ port=6789 accept' --permanent

firewall-cmd --zone=public --add-rich-rule='rule family=ipv4 \ source address=IP_ADDRESS/NETMASK_PREFIX port protocol=tcp \ port=6789 accept' --permanentCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 置き換え

- IP_ADDRESS は、Monitor ノードのネットワークアドレスに置き換えます。

NETMASK_PREFIX は、CIDR 表記のネットマスクに置き換えます。

例

firewall-cmd --zone=public --add-rich-rule='rule family=ipv4 \ source address=192.168.0.11/24 port protocol=tcp \ port=6789 accept' --permanent

[root@monitor ~]# firewall-cmd --zone=public --add-rich-rule='rule family=ipv4 \ source address=192.168.0.11/24 port protocol=tcp \ port=6789 accept' --permanentCopy to Clipboard Copied! Toggle word wrap Toggle overflow

すべての OSD ノードで、パブリックネットワークでポート

6800-7300を開きます。firewall-cmd --zone=public --add-port=6800-7300/tcp firewall-cmd --zone=public --add-port=6800-7300/tcp --permanent firewall-cmd --permanent --add-service=ceph firewall-cmd --add-service=ceph

[root@osd ~]# firewall-cmd --zone=public --add-port=6800-7300/tcp [root@osd ~]# firewall-cmd --zone=public --add-port=6800-7300/tcp --permanent [root@osd ~]# firewall-cmd --permanent --add-service=ceph [root@osd ~]# firewall-cmd --add-service=cephCopy to Clipboard Copied! Toggle word wrap Toggle overflow 別のクラスターネットワークがある場合には、適切なゾーンでコマンドを繰り返します。

すべての Ceph Manager (

ceph-mgr) ノードで、パブリックネットワークでポート6800-7300を開きます。firewall-cmd --zone=public --add-port=6800-7300/tcp firewall-cmd --zone=public --add-port=6800-7300/tcp --permanent

[root@monitor ~]# firewall-cmd --zone=public --add-port=6800-7300/tcp [root@monitor ~]# firewall-cmd --zone=public --add-port=6800-7300/tcp --permanentCopy to Clipboard Copied! Toggle word wrap Toggle overflow 別のクラスターネットワークがある場合には、適切なゾーンでコマンドを繰り返します。

すべての Ceph Metadata Server (

ceph-mds) ノードにおいて、パブリックネットワークでポート6800-7300を開きます。firewall-cmd --zone=public --add-port=6800-7300/tcp firewall-cmd --zone=public --add-port=6800-7300/tcp --permanent

[root@monitor ~]# firewall-cmd --zone=public --add-port=6800-7300/tcp [root@monitor ~]# firewall-cmd --zone=public --add-port=6800-7300/tcp --permanentCopy to Clipboard Copied! Toggle word wrap Toggle overflow 別のクラスターネットワークがある場合には、適切なゾーンでコマンドを繰り返します。

すべての Ceph Object Gateway ノードで、パブリックネットワーク上の関連するポートを開きます。

デフォルトの Ansible が設定されたポート

8080を開くには、以下のコマンドを実行します。firewall-cmd --zone=public --add-port=8080/tcp firewall-cmd --zone=public --add-port=8080/tcp --permanent

[root@gateway ~]# firewall-cmd --zone=public --add-port=8080/tcp [root@gateway ~]# firewall-cmd --zone=public --add-port=8080/tcp --permanentCopy to Clipboard Copied! Toggle word wrap Toggle overflow ソースアドレスに基づいてアクセスを制限するには、以下を実行します。

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="8080" accept"

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="8080" accept"Copy to Clipboard Copied! Toggle word wrap Toggle overflow firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="8080" accept" --permanent

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="8080" accept" --permanentCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 置き換え

- IP_ADDRESS は、Monitor ノードのネットワークアドレスに置き換えます。

NETMASK_PREFIX は、CIDR 表記のネットマスクに置き換えます。

例

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="192.168.0.31/24" port protocol="tcp" \ port="8080" accept"

[root@gateway ~]# firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="192.168.0.31/24" port protocol="tcp" \ port="8080" accept"Copy to Clipboard Copied! Toggle word wrap Toggle overflow firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="192.168.0.31/24" port protocol="tcp" \ port="8080" accept" --permanent

[root@gateway ~]# firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="192.168.0.31/24" port protocol="tcp" \ port="8080" accept" --permanentCopy to Clipboard Copied! Toggle word wrap Toggle overflow

必要に応じて、Ansible を使用して Ceph Object Gateway をインストールし、使用する Ceph Object Gateway を Ansible が設定するデフォルトのポートを

8080からポート80に変更した場合は、次のポートを開きます。firewall-cmd --zone=public --add-port=80/tcp firewall-cmd --zone=public --add-port=80/tcp --permanent

[root@gateway ~]# firewall-cmd --zone=public --add-port=80/tcp [root@gateway ~]# firewall-cmd --zone=public --add-port=80/tcp --permanentCopy to Clipboard Copied! Toggle word wrap Toggle overflow ソースアドレスに基づいてアクセスを制限するには、以下のコマンドを実行します。

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="80" accept"

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="80" accept"Copy to Clipboard Copied! Toggle word wrap Toggle overflow firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="80" accept" --permanent

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="80" accept" --permanentCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 置き換え

- IP_ADDRESS は、Monitor ノードのネットワークアドレスに置き換えます。

- NETMASK_PREFIX は、CIDR 表記のネットマスクに置き換えます。

例

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="192.168.0.31/24" port protocol="tcp" \ port="80" accept"

[root@gateway ~]# firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="192.168.0.31/24" port protocol="tcp" \ port="80" accept"Copy to Clipboard Copied! Toggle word wrap Toggle overflow firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="192.168.0.31/24" port protocol="tcp" \ port="80" accept" --permanent

[root@gateway ~]# firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="192.168.0.31/24" port protocol="tcp" \ port="80" accept" --permanentCopy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: SSL/TLS を使用するには、

443ポートを開きます。firewall-cmd --zone=public --add-port=443/tcp firewall-cmd --zone=public --add-port=443/tcp --permanent

[root@gateway ~]# firewall-cmd --zone=public --add-port=443/tcp [root@gateway ~]# firewall-cmd --zone=public --add-port=443/tcp --permanentCopy to Clipboard Copied! Toggle word wrap Toggle overflow ソースアドレスに基づいてアクセスを制限するには、以下のコマンドを実行します。

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="443" accept"

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="443" accept"Copy to Clipboard Copied! Toggle word wrap Toggle overflow firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="443" accept" --permanent

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="443" accept" --permanentCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 置き換え

- IP_ADDRESS は、Monitor ノードのネットワークアドレスに置き換えます。

- NETMASK_PREFIX は、CIDR 表記のネットマスクに置き換えます。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

関連情報

- パブリックネットワークおよびクラスターネットワークの詳細は、Red Hat Ceph Storage のネットワーク設定の確認 を参照してください。

-

firewalldの詳細は、Red Hat Enterprise Linux 8 のネットワークのセキュリティー保護の firewalld の使用および設定 の章を参照してください。

3.8. sudo アクセスのある Ansible ユーザーの作成

Ansible は、ソフトウェアをインストールし、パスワードを要求せずに設定ファイルを作成するための root 権限を持つユーザーとして、すべての Red Hat Ceph Storage (RHCS) ノードにログインできる必要があります。Ansible を使用して Red Hat Ceph Storage クラスターをデプロイおよび設定する際に、ストレージクラスター内のすべてのノードにパスワードなしの root アクセスで Ansible ユーザーを作成する必要があります。

前提条件

-

ストレージクラスター内のすべてのノードへの

rootまたはsudoアクセスがある。

手順

rootユーザーとしてノードにログインします。ssh root@HOST_NAME

ssh root@HOST_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow - 置き換え

HOST_NAME は、Ceph ノードのホスト名に置き換えます。

例

ssh root@mon01

# ssh root@mon01Copy to Clipboard Copied! Toggle word wrap Toggle overflow プロンプトに従い

rootパスワードを入力します。

新しい Ansible ユーザーを作成します。

adduser USER_NAME

adduser USER_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow - 置き換え

USER_NAME は、Ansible ユーザーの新しいユーザー名に置き換えます。

例

adduser admin

# adduser adminCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要cephをユーザー名として使用しないでください。cephユーザー名は、Ceph デーモン用に予約されます。クラスター全体で統一されたユーザー名を使用すると、使いやすさが向上しますが、侵入者は通常、そのユーザー名をブルートフォース攻撃に使用するため、明白なユーザー名の使用は避けてください。

このユーザーに新しいパスワードを設定します。

passwd USER_NAME

# passwd USER_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow - 置き換え

USER_NAME は、Ansible ユーザーの新しいユーザー名に置き換えます。

例

passwd admin

# passwd adminCopy to Clipboard Copied! Toggle word wrap Toggle overflow プロンプトが表示されたら、新しいパスワードを 2 回入力します。

新規に作成されたユーザーの

sudoアクセスを設定します。cat << EOF >/etc/sudoers.d/USER_NAME $USER_NAME ALL = (root) NOPASSWD:ALL EOF

cat << EOF >/etc/sudoers.d/USER_NAME $USER_NAME ALL = (root) NOPASSWD:ALL EOFCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 置き換え

USER_NAME は、Ansible ユーザーの新しいユーザー名に置き換えます。

例

cat << EOF >/etc/sudoers.d/admin admin ALL = (root) NOPASSWD:ALL EOF

# cat << EOF >/etc/sudoers.d/admin admin ALL = (root) NOPASSWD:ALL EOFCopy to Clipboard Copied! Toggle word wrap Toggle overflow

正しいファイル権限を新しいファイルに割り当てます。

chmod 0440 /etc/sudoers.d/USER_NAME

chmod 0440 /etc/sudoers.d/USER_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow - 置き換え

USER_NAME は、Ansible ユーザーの新しいユーザー名に置き換えます。

例

chmod 0440 /etc/sudoers.d/admin

# chmod 0440 /etc/sudoers.d/adminCopy to Clipboard Copied! Toggle word wrap Toggle overflow

関連情報

- Red Hat Enterprise Linux 8 の基本的なシステム設定の設定の ユーザーアカウントの管理 セクション

3.9. Ansible のパスワードなし SSH の有効化

Ansible 管理ノードで SSH キーペアを生成し、ストレージクラスター内の各ノードに公開キーを配布して、Ansible がパスワードの入力を求められることなくノードにアクセスできるようにします。

Cockpit の Web ベースのインターフェイスを使用して Red Hat Ceph Storage をインストールする場合は、この手順は必要ありません。これは、Cockpit Ceph Installer により独自の SSH キーが生成されるためです。クラスターのすべてのノードに Cockpit SSH キーをコピー の手順は、Cockpit Web インターフェイスを使用した Red Hat Ceph Storage のインストール の章になります。

前提条件

- Ansible 管理ノードへのアクセス

-

sudoアクセスのある Ansible ユーザーの作成

手順

SSH キーペアを生成し、デフォルトのファイル名を受け入れ、パスフレーズを空のままにします。

ssh-keygen

[ansible@admin ~]$ ssh-keygenCopy to Clipboard Copied! Toggle word wrap Toggle overflow 公開鍵をストレージクラスター内のすべてのノードにコピーします。

ssh-copy-id USER_NAME@HOST_NAME

ssh-copy-id USER_NAME@HOST_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow - 置き換え

- USER_NAME は、Ansible ユーザーの新しいユーザー名に置き換えます。

HOST_NAME は、Ceph ノードのホスト名に置き換えます。

例

ssh-copy-id ceph-admin@ceph-mon01

[ansible@admin ~]$ ssh-copy-id ceph-admin@ceph-mon01Copy to Clipboard Copied! Toggle word wrap Toggle overflow

ユーザーの SSH の

configファイルを作成します。touch ~/.ssh/config

[ansible@admin ~]$ touch ~/.ssh/configCopy to Clipboard Copied! Toggle word wrap Toggle overflow configファイルを編集するために開きます。ストレージクラスター内の各ノードのHostnameおよびUserオプションの値を設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 置き換え

- HOST_NAME は、Ceph ノードのホスト名に置き換えます。

USER_NAME は、Ansible ユーザーの新しいユーザー名に置き換えます。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要~/.ssh/configファイルを設定すると、ansible-playbookコマンドを実行するたびに-u USER_NAMEオプションを指定する必要がありません。

~/.ssh/configファイルに正しいファイルパーミッションを設定します。chmod 600 ~/.ssh/config

[admin@admin ~]$ chmod 600 ~/.ssh/configCopy to Clipboard Copied! Toggle word wrap Toggle overflow

関連情報

-

ssh_config(5)の man ページ。 - Red Hat Enterprise Linux 8 のネットワークのセキュリティー保護の章の 2 台のシステム間で OpenSSH を使用した安全な通信の使用 の章を参照してください。

第4章 Cockpit Web インターフェイスを使用した Red Hat Ceph Storage のインストール

本章では、Cockpit Web ベースのインターフェイスを使用して、Red Hat Ceph Storage クラスターおよびその他のコンポーネント (メタデータサーバー、Ceph クライアント、Ceph Object Gateway など) をインストールする方法を説明します。

このプロセスは、Cockpit Ceph インストーラーのインストール、Cockpit へのログイン、およびインストーラー内の異なるページを使用してクラスターのインストールの設定と開始で設定されます。

Cockpit Ceph Installer は、実際のインストールを実行するために、ceph-ansible RPM によって提供される Ansible および Ansible Playbook を使用します。これらの Playbook を使用して、Cockpit を使用せずに Ceph をインストールすることは引き続き可能です。このプロセスは本章に関連し、直接の Ansible インストール t または Ansible Playbook を直接使用 と呼ばれています。

Cockpit Ceph インストーラーは、現在 IPv6 ネットワークをサポートしていません。IPv6 ネットワークが必要な場合は、Ansible Playbook を使用して Ceph を直接 インストールします。

Ceph の管理と監視に使用されるダッシュボード Web インターフェイスは、Cockpit がバックエンドで使用する ceph-ansible RPM の Ansible Playbook によってデフォルトでインストールされます。したがって、Ansible Playbook を直接使用する場合や、Cockpit を使用して Ceph をインストールしたりしても、Dashboard の Web インターフェイスもインストールされます。

4.1. 前提条件

- Ansible Red Hat Ceph Storage の直接インストールに必要な 一般的な前提条件 を完了してください。

- Firefox または Chrome の最新バージョン。

- 複数のネットワークを使用してクラスター内トラフィック、クライアントからクラスターへのトラフィック、RADOS ゲートウェイトラフィック、または iSCSI トラフィックをセグメント化する場合は、関連するネットワークがホスト上ですでに設定されていることを確認してください。詳細は、ハードウェアガイド の ネットワークの留意事項 と、Cockpit Ceph Installer のネットワークページの完了 のこの章のこのセクションを参照してください。

-

Cockpit Web ベースのインターフェイスのデフォルトポート

9090にアクセスできることを確認します。

4.2. インストール要件

- Ansible 管理ノードとして機能する 1 つのノード。

- パフォーマンスメトリックおよびアラートプラットフォームを提供するノード。これは、Ansible 管理ノードと同じ場所に配置することができます。

- Ceph クラスターを設定する 1 つ以上のノード。インストーラーは、Development/POC と呼ばれるオールインワンインストールをサポートします。このモードでは、全 Ceph サービスを同じノードから実行でき、データレプリケーションはデフォルトでホストレベルの保護ではなく、ディスクにデフォルト設定されます。

4.3. Cockpit Ceph Installer のインストールおよび設定

Cockpit Ceph Installer を使用して Red Hat Ceph Storage クラスターをインストールする前に、Cockpit Ceph Installer を Ansible 管理ノードにインストールする必要があります。

前提条件

- Ansible 管理ノードへのルートレベルのアクセス。

-

Ansible アプリケーションで使用する

ansibleユーザーアカウント。

手順

Cockpit がインストールされていることを確認します。

rpm -q cockpit

$ rpm -q cockpitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

rpm -q cockpit cockpit-196.3-1.el8.x86_64

[admin@jb-ceph4-admin ~]$ rpm -q cockpit cockpit-196.3-1.el8.x86_64Copy to Clipboard Copied! Toggle word wrap Toggle overflow 上記の例と同様の出力が表示された場合は、確認用 Cockpit が実行している ステップに進みます。出力が

package cockpit is not installedされていない場合は、Install Cockpit のステップに進みます。必要に応じて Cockpit をインストールします。

Red Hat Enterprise Linux 8 の場合:

dnf install cockpit

# dnf install cockpitCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 7 の場合:

yum install cockpit

# yum install cockpitCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Cockpit が実行中であることを確認します。

systemctl status cockpit.socket

# systemctl status cockpit.socketCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力に

Active: active (listening)が表示されている場合は、Red Hat Ceph Storage 用の Cockpit プラグインのインストール 手順に進みます。代わりにActive: inactive(dead)と表示される場合には、Cockpit の有効化 手順に進んでください。必要に応じて、Cockpit を有効にします。

systemctlコマンドを使用して、Cockpit を有効にします。systemctl enable --now cockpit.socket

# systemctl enable --now cockpit.socketCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のような行が表示されます。

Created symlink /etc/systemd/system/sockets.target.wants/cockpit.socket → /usr/lib/systemd/system/cockpit.socket.

Created symlink /etc/systemd/system/sockets.target.wants/cockpit.socket → /usr/lib/systemd/system/cockpit.socket.Copy to Clipboard Copied! Toggle word wrap Toggle overflow Cockpit が実行中であることを確認します。

systemctl status cockpit.socket

# systemctl status cockpit.socketCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のような行が表示されます。

Active: active (listening) since Tue 2020-01-07 18:49:07 EST; 7min ago

Active: active (listening) since Tue 2020-01-07 18:49:07 EST; 7min agoCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Red Hat Ceph Storage 用の Cockpit Ceph Installer をインストールします。

Red Hat Enterprise Linux 8 の場合:

dnf install cockpit-ceph-installer

# dnf install cockpit-ceph-installerCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 7 の場合:

yum install cockpit-ceph-installer

# yum install cockpit-ceph-installerCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Ansible ユーザーとして、sudo を使用してコンテナーカタログにログインします。

注記デフォルトでは、Cockpit Ceph Installer は

rootユーザーを使用して Ceph をインストールします。Ceph をインストールするための前提条件の一部として作成した Ansible ユーザーを使用するには、この手順の残りのコマンドを実行し、sudoを Ansible ユーザーとして実行します。Red Hat Enterprise Linux 7

sudo docker login -u CUSTOMER_PORTAL_USERNAME https://registry.redhat.io

$ sudo docker login -u CUSTOMER_PORTAL_USERNAME https://registry.redhat.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

sudo docker login -u myusername https://registry.redhat.io Password: Login Succeeded!

[admin@jb-ceph4-admin ~]$ sudo docker login -u myusername https://registry.redhat.io Password: Login Succeeded!Copy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 8

sudo podman login -u CUSTOMER_PORTAL_USERNAME https://registry.redhat.io

$ sudo podman login -u CUSTOMER_PORTAL_USERNAME https://registry.redhat.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

sudo podman login -u myusername https://registry.redhat.io Password: Login Succeeded!

[admin@jb-ceph4-admin ~]$ sudo podman login -u myusername https://registry.redhat.io Password: Login Succeeded!Copy to Clipboard Copied! Toggle word wrap Toggle overflow registry.redhat.ioがコンテナーレジストリーの検索パスにあることを確認します。編集するために、

/etc/containers/registries.confファイルを開きます。[registries.search] registries = [ 'registry.access.redhat.com', 'registry.fedoraproject.org', 'registry.centos.org', 'docker.io']

[registries.search] registries = [ 'registry.access.redhat.com', 'registry.fedoraproject.org', 'registry.centos.org', 'docker.io']Copy to Clipboard Copied! Toggle word wrap Toggle overflow registry.redhat.ioがファイルに含まれていない場合は、これを追加します。[registries.search] registries = ['registry.redhat.io', 'registry.access.redhat.com', 'registry.fedoraproject.org', 'registry.centos.org', 'docker.io']

[registries.search] registries = ['registry.redhat.io', 'registry.access.redhat.com', 'registry.fedoraproject.org', 'registry.centos.org', 'docker.io']Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Ansible ユーザーとして、sudo を使用して

ansible-runner-serviceを起動します。sudo ansible-runner-service.sh -s

$ sudo ansible-runner-service.sh -sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力の最後の行には、Cockpit Ceph Installer の URL が含まれます。上記の例では、URL は

https://jb-ceph4-admin:9090/cockpit-ceph-installerです。お使いの環境で出力される URL を書き留めておきます。

4.4. Cockpit Ceph Installer SSH 鍵をクラスター内のすべてのノードにコピーします。

Cockpit Ceph Installer は、SSH を使用してクラスター内のノードに接続し、設定します。これを実行するために、インストーラーは SSH キーペアを生成し、パスワードを求められることなくノードにアクセスできるようにします。SSH 公開鍵はクラスター内のすべてのノードに転送される必要があります。

前提条件

- sudo アクセスを持つ Ansible ユーザー が作成されました。

- Cockpit Ceph Installer が インストールされ、設定されている。

手順

Ansible 管理ノードに Ansible ユーザーとしてログインします。

ssh ANSIBLE_USER@HOST_NAME

ssh ANSIBLE_USER@HOST_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

ssh admin@jb-ceph4-admin

$ ssh admin@jb-ceph4-adminCopy to Clipboard Copied! Toggle word wrap Toggle overflow SSH 公開鍵を最初のノードにコピーします。

sudo ssh-copy-id -f -i /usr/share/ansible-runner-service/env/ssh_key.pub _ANSIBLE_USER_@_HOST_NAME_

sudo ssh-copy-id -f -i /usr/share/ansible-runner-service/env/ssh_key.pub _ANSIBLE_USER_@_HOST_NAME_Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow クラスターのすべてのノードに対してこの手順を繰り返します。

4.5. Cockpit へのログイン

Cockpit Ceph Installer の Web インターフェイスは、Cockpit にログインして確認することができます。

前提条件

- Cockpit Ceph Installer が インストールされ、設定されている。

- Cockpit Ceph Installer の設定の一部として URL が出力されていること。

手順

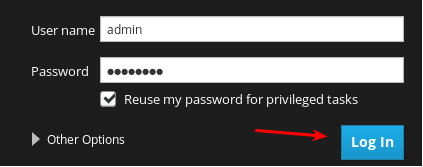

Web ブラウザーで URL を開きます。

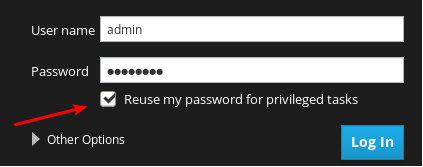

Ansible ユーザー名およびそのパスワードを入力します。

特権タスクにパスワードを再使用 するラジオボタンをクリックします。

Log In をクリックします。

Welcome ページをチェックして、インストーラーの動作方法とインストールプロセスの全体的なフローを確認します。

Welcome ページで情報を確認したら、Web ページの右下隅にある Environment ボタンをクリックします。

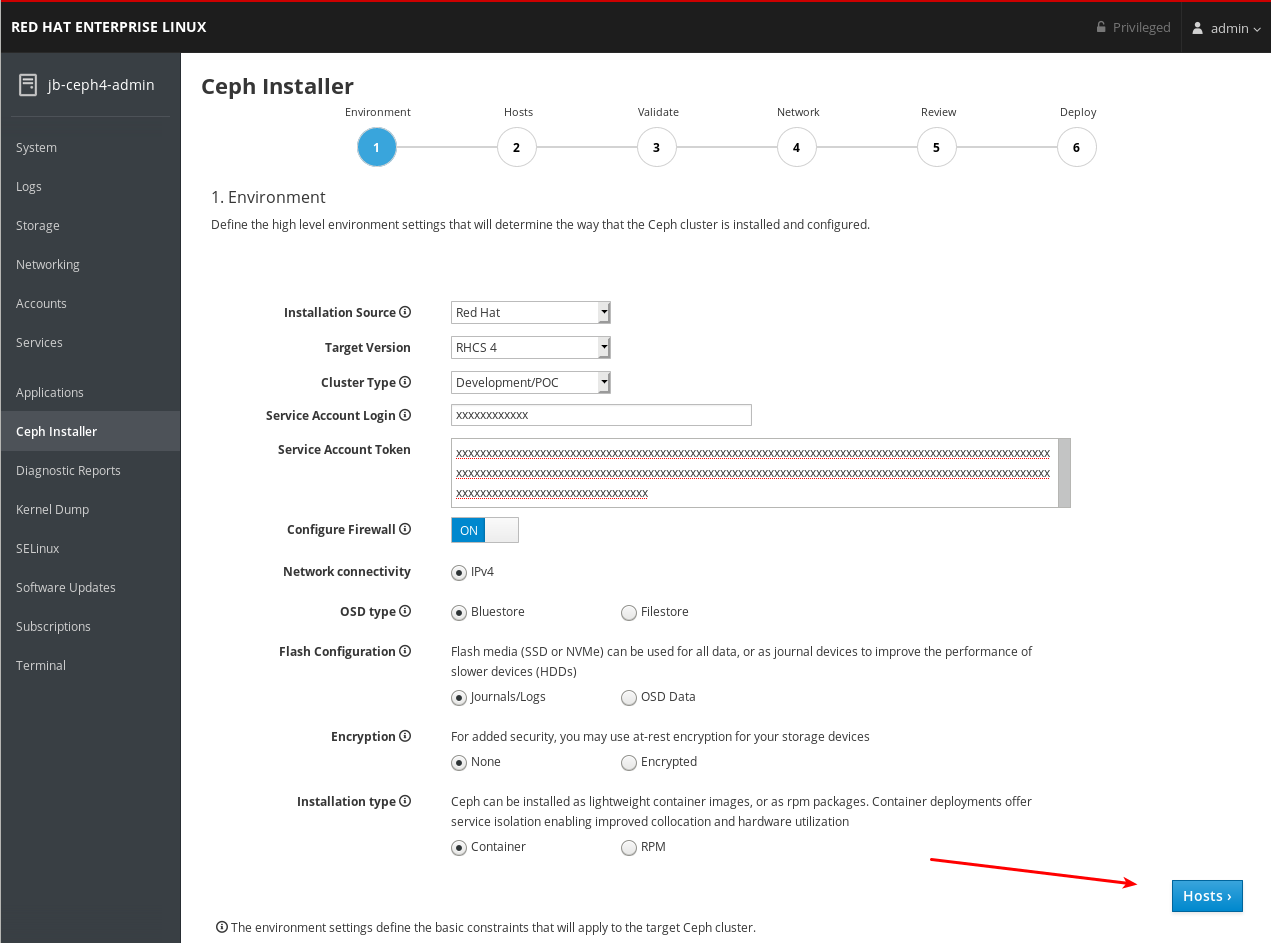

4.6. Cockpit Ceph インストーラーの環境ページの完了

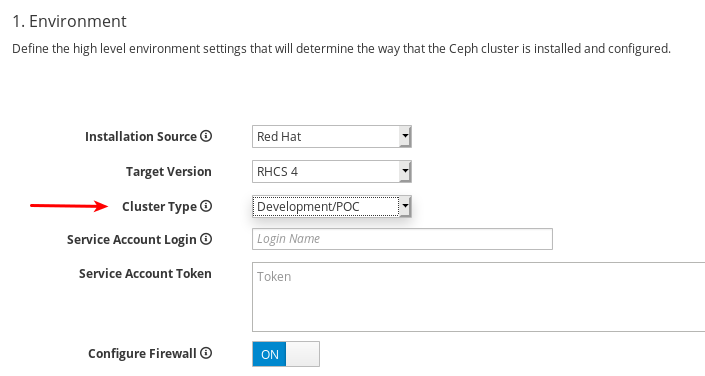

Environment ページでは、使用するインストールソースや、ストレージにハードディスクドライブ (HDD) とソリッドステートドライブ (SSD) を使用する方法など、クラスターの全体的な側面を設定できます。

前提条件

- Cockpit Ceph Installer が インストールされ、設定されている。

- Cockpit Ceph Installer の設定の一部として URL が出力されている必要があります。

- レジストリーサービスアカウント を作成している。

続いて表示されるダイアログには、一部の設定の右側にあるツールチップがあります。これを表示するには、そのあたりに i のようなアイコンにマウスカーソルを合わせたカーソルをかざすようにカーソルを合わせます。

手順

インストールソース を選択します。Red Hat カスタマーポータルからダウンロードした CD イメージを使用するには、Red Hat Subscription Manager からリポジトリーを使用するか、ISO を選択します。

Red Hat を選択した場合は、他のオプションを指定せずに Target Version が RHCS 4 に設定されます。ISO を選択すると、Target Version が ISO イメージファイルに設定されます。

重要ISO を選択する場合、イメージファイルは

/usr/share/ansible-runner-service/isoディレクトリーにあり、その SELinux コンテキストはcontainer_file_tに設定する必要があります。重要インストールソース の コミュニティー オプションおよび ディストリビューション オプションには対応していません。

Cluster Type を選択します。実稼働 の選択では、CPU 番号やメモリーサイズなどの特定のリソース要件を満たしていないと、インストールが続行できなくなります。リソース要件を満たしている場合でもクラスターのインストールを続行できるようにするには、Development/POC を選択します。

重要

重要Development/POC モードは、実稼働環境で使用する Ceph クラスターをインストールしないでください。

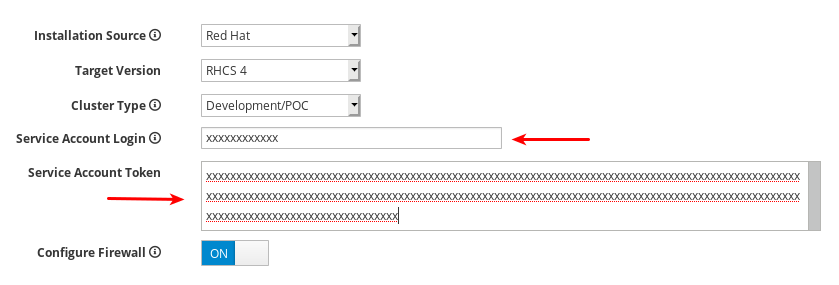

Service Account Login および Service Account Token を設定します。Red Hat レジストリーサービスアカウントがない場合は、レジストリーサービスアカウントの Web ページ を使用して作成します。

Configure Firewall を ON に設定して、Ceph サービスのポートを開くルールを

firewalldに適用します。firewalldを使用していない場合は、OFF 設定を使用します。

現在、Cockpit Ceph Installer は IPv4 のみをサポートしています。IPv6 サポートが必要な場合は、Cockpit Ceph Installer を使用を停止し、Ansible スクリプトを直接 使用して Ceph のインストールに進む必要があります。

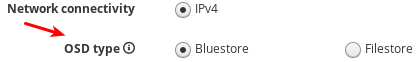

OSD Type を BlueStore または FileStore に設定します。

重要

重要BlueStore はデフォルトの OSD タイプです。以前のバージョンでは、Ceph は FileStore をオブジェクトストアとして使用していました。BlueStore はより多くの機能を提供し、パフォーマンスを向上させるため、この形式は Red Hat Ceph Storage 4.0 で非推奨になっています。FileStore は依然として使用できますが、サポート例外が必要です。BlueStore の詳細は、アーキテクチャーガイド の Ceph BlueStore を参照してください。

Flash Configuration を Journal/Logs または OSD データ に設定します。ソリッドステートドライブ (SSD) を使用している場合は、NVMe または従来の SATA/SAS インターフェイスのどちらを使用する場合でも、実際のデータがハードディスクドライブ (HDD) に保存されている間、ジャーナルとログの書き込みにのみ使用することを選択できます。ジャーナリング、ログ、およびデータに SSD を使用し、CephOSD 機能に HDD を使用しないでください。

Encryption を None または Encrypted に設定します。これは、LUKS1 形式を使用したストレージデバイスの残り暗号化を指します。

インストールタイプ を Container または RPM に設定します。従来は、Red Hat Enterprise Linux にソフトウェアをインストールするのに Red Hat Package Manager (RPM) が使用されていました。これで、RPM またはコンテナーを使用して Ceph をインストールできます。コンテナーを使用して Ceph をインストールすると、サービスを分離して共存させることができるため、ハードウェアの使用率が向上します。

すべての環境設定を確認し、Web ページの右下隅にある Hosts ボタンをクリックします。

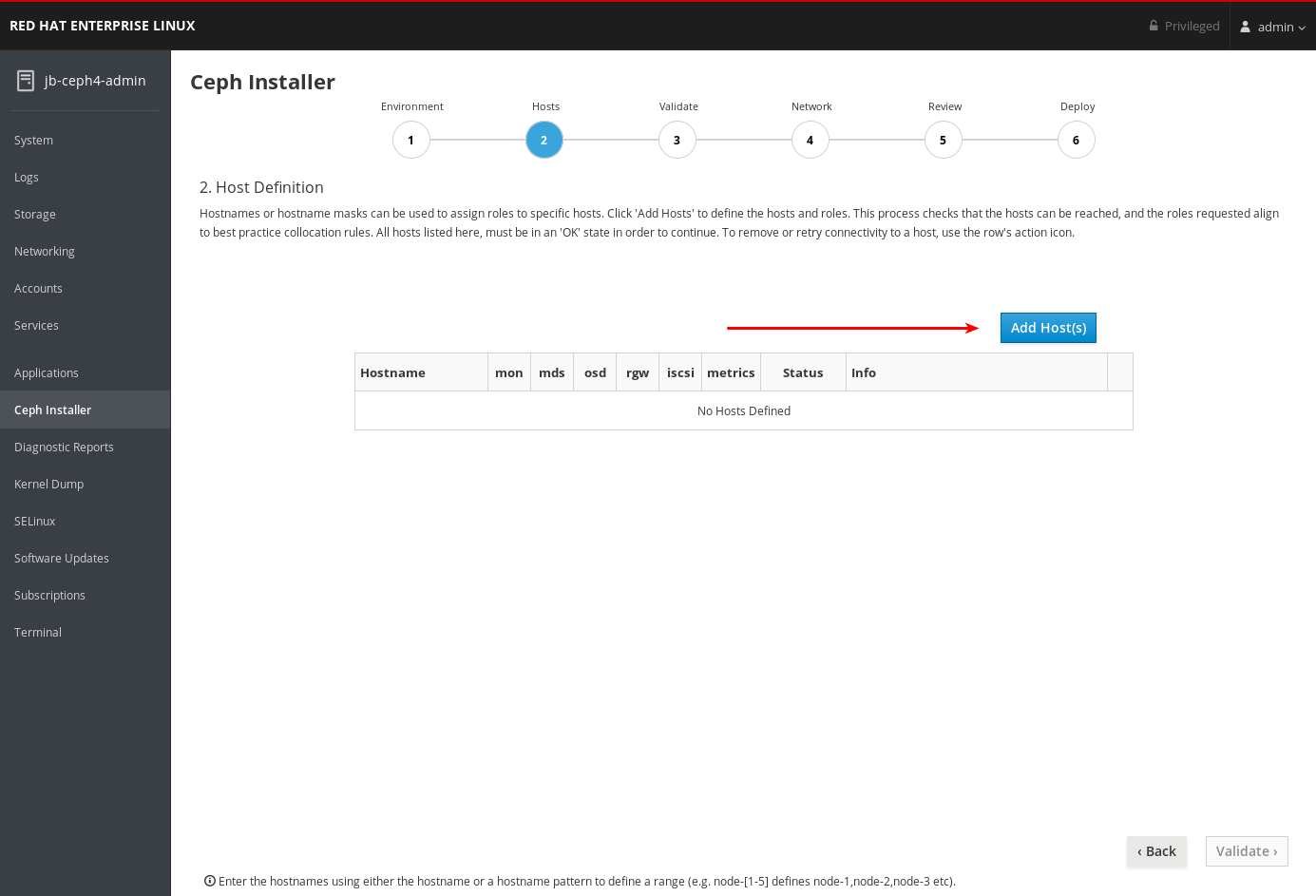

4.7. Cockpit Ceph インストーラーの Hosts ページの完了

Hosts のページでは、Ceph をインストールするホストと各ホストが使用するロールについて Cockpit Ceph Installer に通知することができます。ホストを追加すると、インストーラーは SSH と DNS 接続の有無をチェックします。

前提条件

- Cockpit Ceph Installer の環境ページ が完了している。

- Cockpit Ceph Installer SSH キーが クラスター内のすべてのノードにコピー されている。

手順

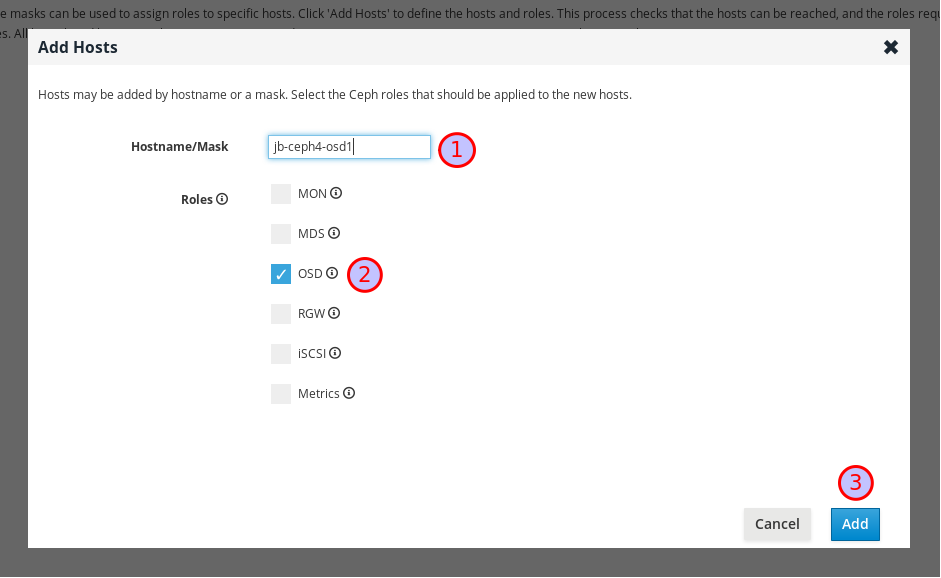

Add Host(s) ボタンをクリックします。

Ceph OSD ノードのホスト名を入力し、OSD のチェックボックスを選択して 追加 ボタンをクリックします。

最初の Ceph OSD ノードが追加されます。

実稼働クラスターの場合、少なくとも 3 つの Ceph OSD ノードを追加するまで、この手順を繰り返します。

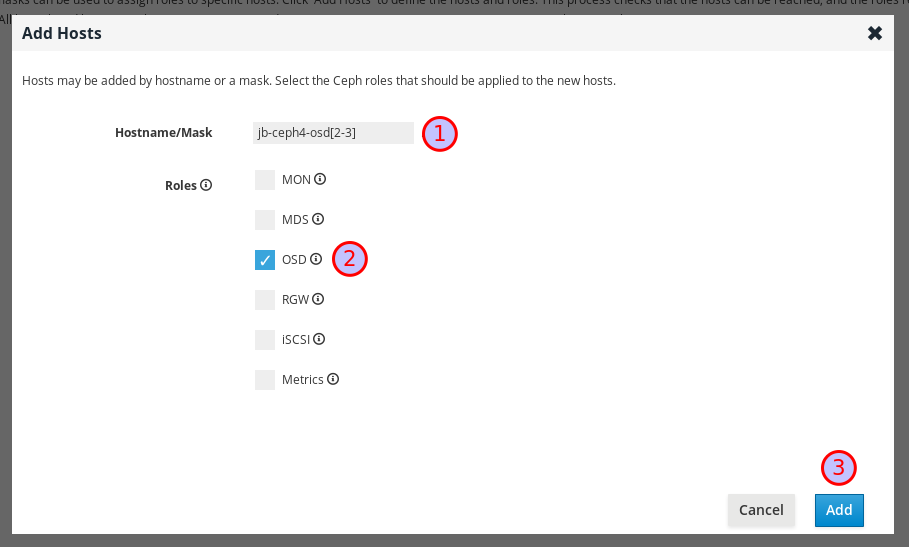

必要に応じて、ホスト名のパターンを使用してノードの範囲を定義します。たとえば、

jb-ceph4-osd2とjb-ceph4-osd3を同時に追加するには、jb-ceph4-osd[2-3]を入力します。

jb-ceph4-osd2とjb-ceph4-ods3の両方が追加されます。

クラスター内の他のノードについて上記の手順を繰り返します。

-

実稼働クラスターの場合は、少なくとも 3 つの Ceph Monitor ノードを追加します。ダイアログでは、ロールは

MONとしてリスト表示されます。 -

Metricsのロールを持つノードを追加します。Metricsロールは Grafana および Prometheus をインストールし、Ceph クラスターのパフォーマンスに関するリアルタイムの洞察を提供します。これらのメトリックは Ceph Dashboard に提示されています。これにより、クラスターの監視および管理が可能になります。Dashboard、Grafana、および Prometheus のインストールが必要です。Ansible Administration ノードでメトリック関数を同じ場所に配置できます。これを実行する場合は、ノードのシステムリソースが スタンドアロンのメトリックノードに必要とされるもの よりも大きいことを確認します。 -

必要に応じて

MDSロールを持つノードを追加します。MDSロールは Ceph Metadata Server (MDS) をインストールします。Ceph File System をデプロイするには、メタデータサーバーデーモンが必要です。 -

必要に応じて

RGWロールを持つノードを追加します。RGWロールは、Ceph Object Gateway もインストールします。RADOS ゲートウェイは、librados API 上に構築されたオブジェクトストレージインターフェイスで、Ceph ストレージクラスターに RESTful ゲートウェイを提供するアプリケーションを提供します。Amazon S3 および OpenStack Swift API をサポートします。 -

必要に応じて

iSCSIロールを持つノードを追加します。iSCSIロールは iSCSI ゲートウェイをインストールするため、iSCSI で Ceph ブロックデバイスを共有することができます。Ceph で iSCSI を使用するには、マルチパス I/O 用に iSCSI ゲートウェイを少なくとも 2 つのノードにインストールする必要があります。

-

実稼働クラスターの場合は、少なくとも 3 つの Ceph Monitor ノードを追加します。ダイアログでは、ロールは

必要に応じて、ノードを追加する際に複数のロールを選択して、同じノードに複数のサービスを割り当てます。

デーモンを同じ場所に配置するデーモンの詳細は、インストールガイド の コンテナー化された Ceph デーモンのコロケーション を参照してください。

必要に応じて、テーブルのロールをオンまたはオフにして、ノードに割り当てられたロールを変更します。

必要に応じて、ノードを削除するには、削除するノードの行の右端にあるケバブアイコンをクリックし、Delete をクリックします。

クラスター内のすべてのノードを追加したら、ページの右下隅にある Validate ボタンをクリックして、必要なロールをすべて設定します。

実稼働クラスターの場合は、3 つまたは 5 台のモニターがない場合に Cockpit Ceph インストーラーは続行されません。この例では、Cluster Type は Development/POC に設定されているため、インストールは 1 つのモニターのみを続行できます。

4.8. Cockpit Ceph インストーラーの Validate ページの完了

Validate ページでは、Hosts ページで指定したノードをプローブし、使用するロールのハードウェア要件を満たしていることを確認してください。

前提条件

- Cockpit Ceph インストーラーのホストページ が完了している。

手順

Probe Hosts ボタンをクリックします。

続行するには、OK ステータス を持つホストを少なくとも 3 台選択する必要があります。

必要に応じて、ホストについて警告またはエラーが生成された場合は、ホストのチェックマークの左側にある矢印をクリックして、問題を表示します。

重要

重要Cluster Type を Production に設定すると、生成されたエラーによって Status が NOTOK となり、インストール用に選択できなくなります。エラーを解決する方法は、次の手順を参照してください。

重要Cluster Type を Development/POC に設定すると、生成されたエラーは警告としてリスト表示されるため、Status は常に OK になります。これにより、ホストが要件や提案を満たしているかどうかに関係なく、ホストを選択して Ceph をインストールできます。必要に応じて警告を解決できます。警告を解決する方法については、次の手順を参照してください。

必要に応じて、エラーと警告を解決するには、以下のメソッドを 1 つ以上使用します。

エラーや警告を解決する最も簡単な方法は、特定のロールを完全に無効にしたり、1 台のホストでロールを無効にして、必要なリソースがある別のホストで有効にすることです。

Development/POC クラスターをインストールしている場合は、警告が残っていても安心して進めることができ、実稼働 クラスターをインストールする場合は、少なくとも 3 台のホストに割り当てられたロールに必要なリソースがすべて揃っていて、警告が残っていても安心して進めることができる組み合わせが見つかるまで、ロールの有効化と無効化を試してみてください。

必要なロールの要件を満たす新規ホストを使用することもできます。まず、ホスト ページに戻り、問題のあるホストを削除します。

次に、新規ホストを追加 します。

- ホストのハードウェアをアップグレードするか、何らかの方法で要件または提案を満たすには、最初にホストに変更を加えてから、再度 ホストのプローブ をクリックします。オペレーティングシステムを再インストールする必要がある場合は、再度 SSH キーをコピーする 必要があります。

ホストの横にあるチェックボックスを選択して、Red Hat Ceph Storage をインストールするホストを選択します。

重要

重要実稼働クラスターをインストールする場合は、インストール用にエラーを選択する前にエラーを解決する必要があります。

ページの右下隅の Network ボタンをクリックして、クラスターのネットワークを確認し、設定します。

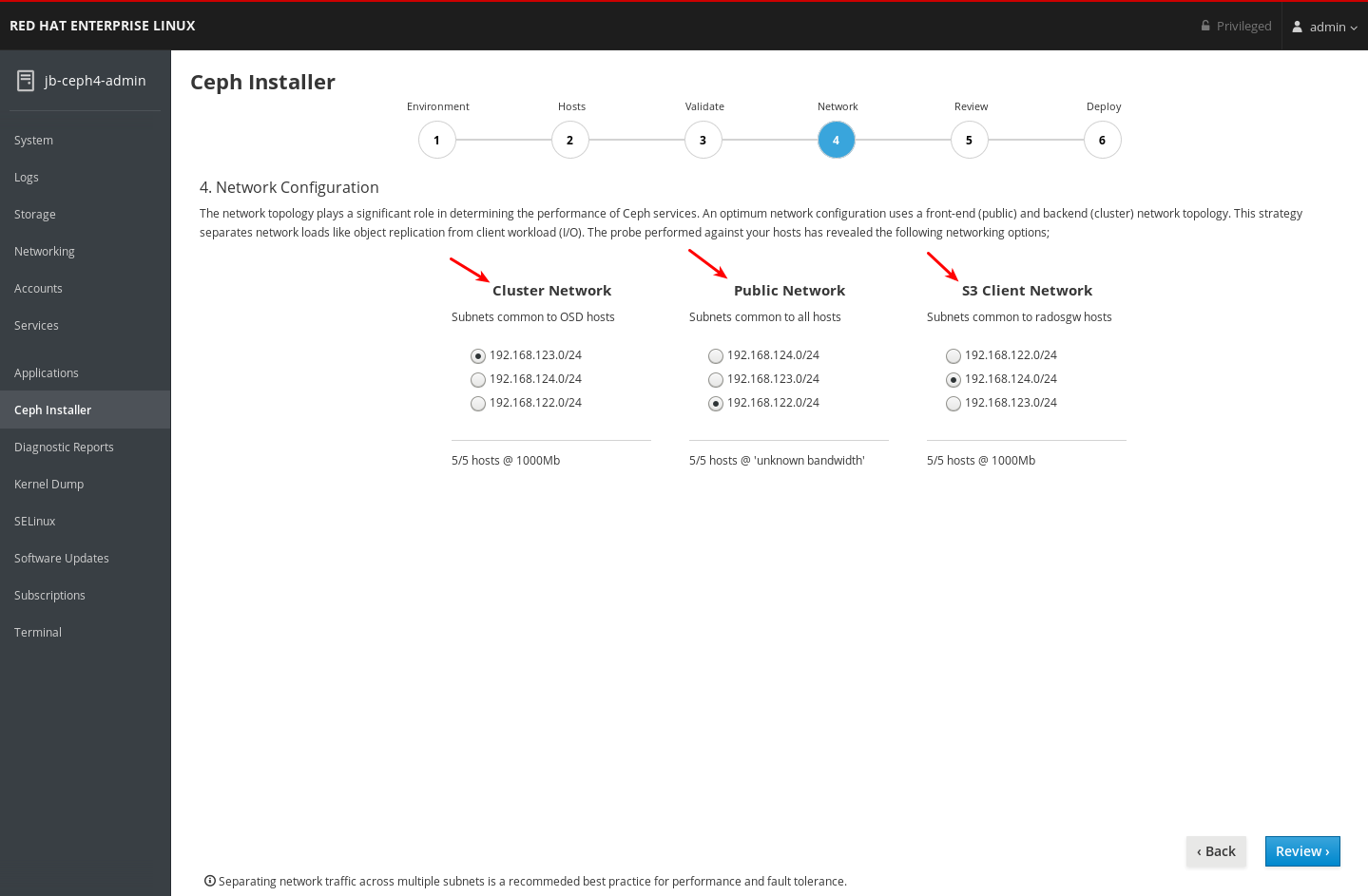

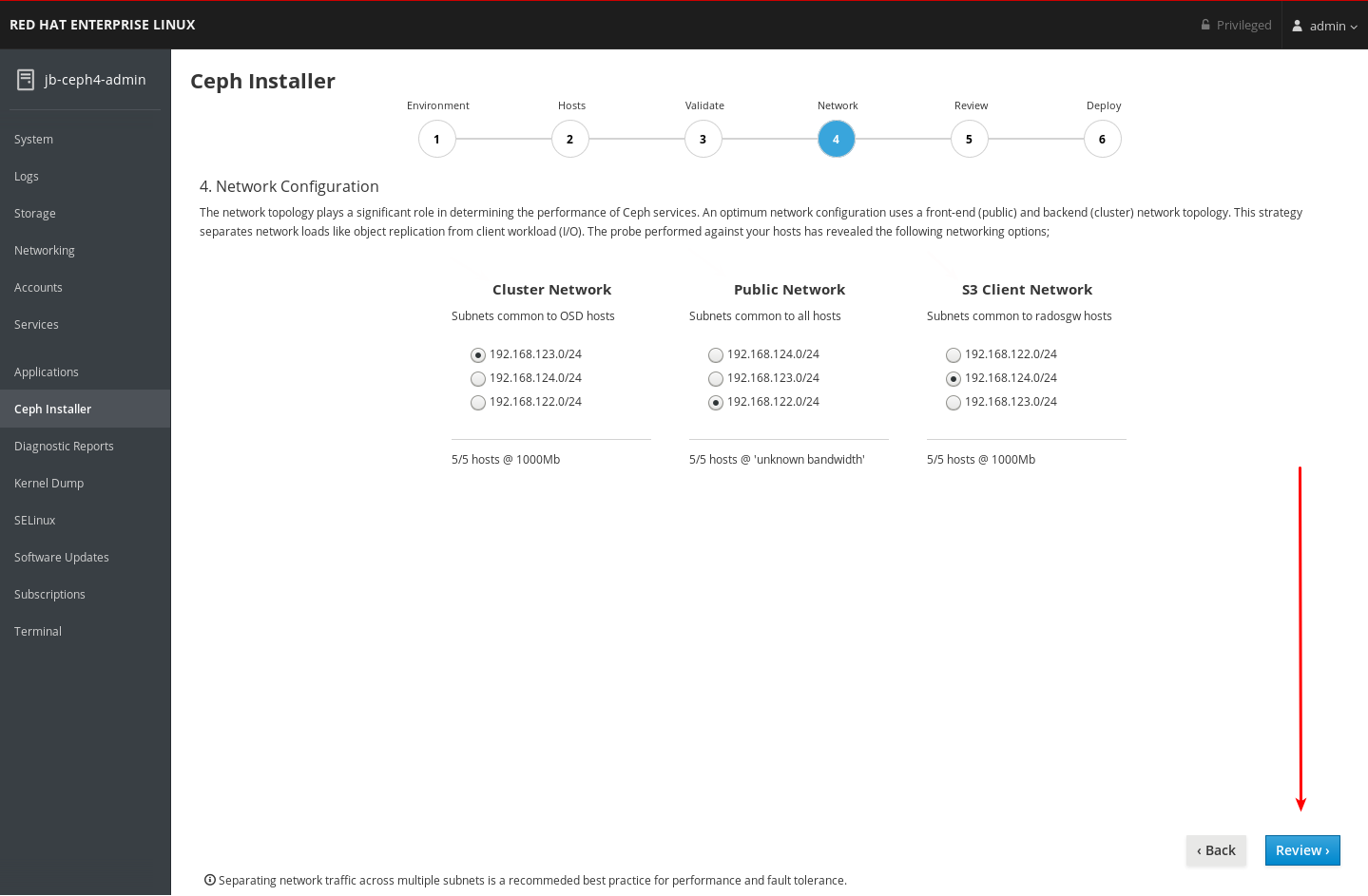

4.9. Cockpit Ceph インストーラーのネットワークページの完了

Network ページでは、特定のクラスター通信タイプを特定のネットワークに分離することができます。これには、クラスターのホスト全体に複数の異なるネットワークを設定する必要があります。

Network ページは、Validate ページで実行されたプローブから収集された情報を使用して、ホストがアクセスできるネットワークを表示します。現在、Network ページにすでに進む場合は、新規ネットワークをホストに追加したり、Validate ページに戻り、ホストを再プローブしてから、再度 Network ページに移動して新しいネットワークを使用することができません。選択のためには表示されません。Network ページに移動してからホストに追加したネットワークを使用するには、Web ページを完全に更新し、最初からインストールを再起動する必要があります。

実稼働クラスターの場合は、クラスター内トラフィックをクライアントからクラスターへのトラフィックから別々の NIC に分離する必要があります。クラスタートラフィックの種別を分離する他に、Ceph クラスターの設定時に、ネットワークについて考慮すべき他の考慮点があります。詳細は、ハードウェアガイド の ネットワークの考慮事項 を参照してください。

前提条件

- Cockpit Ceph インストーラーの Validate ページ が完了しました。

手順

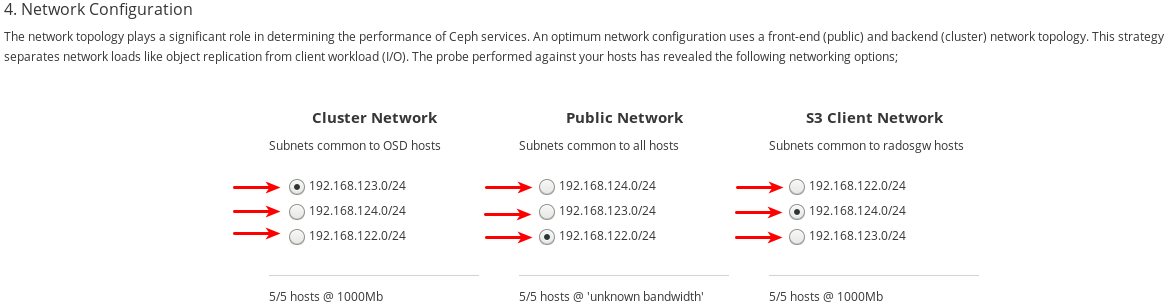

ネットワークページで設定できるネットワーク種別を書き留めておきます。各タイプには独自の列があります。クラスターネットワーク および パブリックネットワーク の列は常に表示されます。RADOS Gateway ロールでホストをインストールする場合は、S3 Network 列が表示されます。iSCSI ロールでホストをインストールする場合は、iSCSI ネットワーク の列が表示されます。以下の例では、Cluster Network、Public Network、および S3 Network の列が表示されます。

各ネットワーク種別に選択できるネットワークを書き留めておきます。特定のネットワーク種別を設定する全ホストで利用可能なネットワークのみが表示されます。以下の例では、クラスター内の全ホストで利用可能なネットワークが 3 つあります。3 つのネットワークはすべて、ネットワーク種別を設定する全ホストセットで利用可能であるため、各ネットワーク種別には同じ 3 つのネットワークがリスト表示されます。

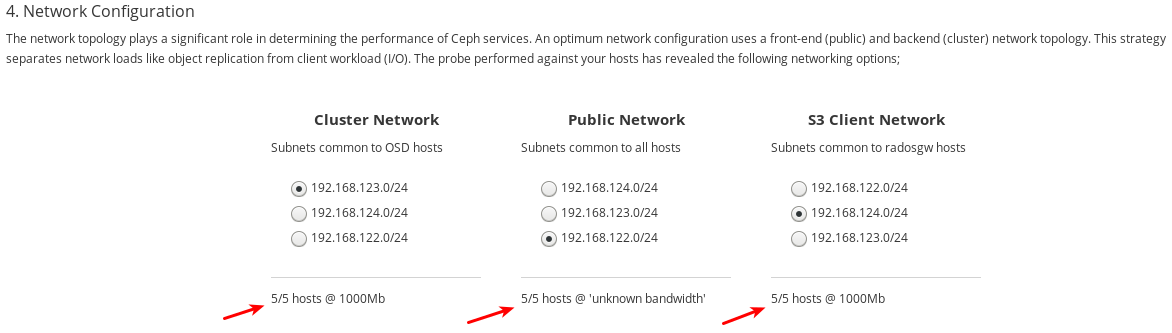

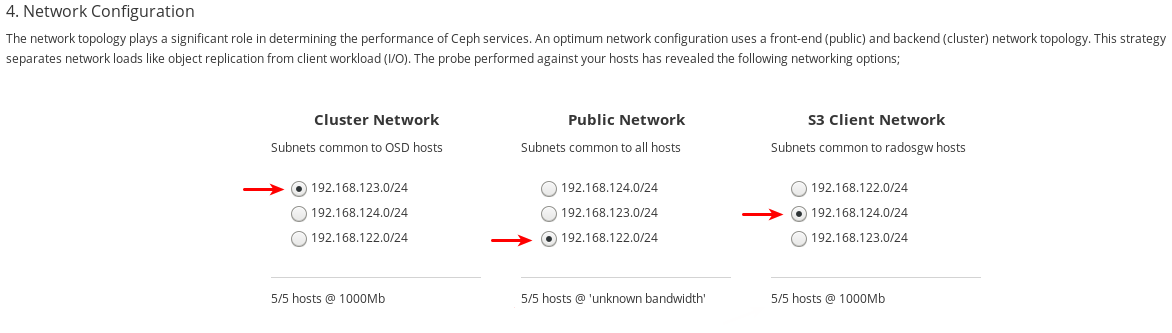

利用可能な 3 つのネットワークは、

192.168.122.0/24、192.168.123.0/24、および192.168.124.0/24です。各ネットワークが操作する速度を書き留めておきます。これは、特定のネットワークに使用される NIC の速度です。以下の例では、

192.168.123.0/24および192.168.124.0/24は 1,000 mbps になります。Cockpit Ceph Installer は192.168.122.0/24ネットワークの速度を把握できませんでした。

各ネットワークタイプに使用するネットワークを選択します。実稼働クラスターの場合は、Cluster Network および Public Network 用に別個のネットワークを選択する必要があります。Development/POC クラスターでは、両方のタイプに同じネットワークを選択するか、すべてのホストにネットワークが 1 つのみ設定されている場合は、そのネットワークのみが表示され、他のネットワークを選択できなくなります。

192.168.122.0/24ネットワークは パブリックネットワーク に使用され、192.168.123.0/24ネットワークが クラスターネットワーク に使用されます。また、192.168.124.0/24ネットワークは S3 ネットワーク に使用されます。ページの右下隅にある Review ボタンをクリックして、インストール前にクラスター設定全体を確認します。

4.10. インストール設定の確認

Review ページを使用すると、前のページで設定した Ceph クラスターのインストール設定の詳細と、以前のページに含まれていなかったホストに関する詳細を表示できます。

前提条件

- Cockpit Ceph Installer のネットワークページ が完了している。

手順

レビューページを表示します。

Review ページに表示されるように、各ページの情報が予想どおりに表示されていることを確認します。Environment ページの情報の概要が 1、Hosts ページが 2、Validate ページが 3、Network ページが 4、ホストの詳細 (前のページには含まれていなかったいくつかの追加の詳細を含む) が 5 にあります。

ページの右下隅にある Deploy ボタンをクリックして、実際のインストールプロセスを確定および開始できる Deploy ページに移動します。

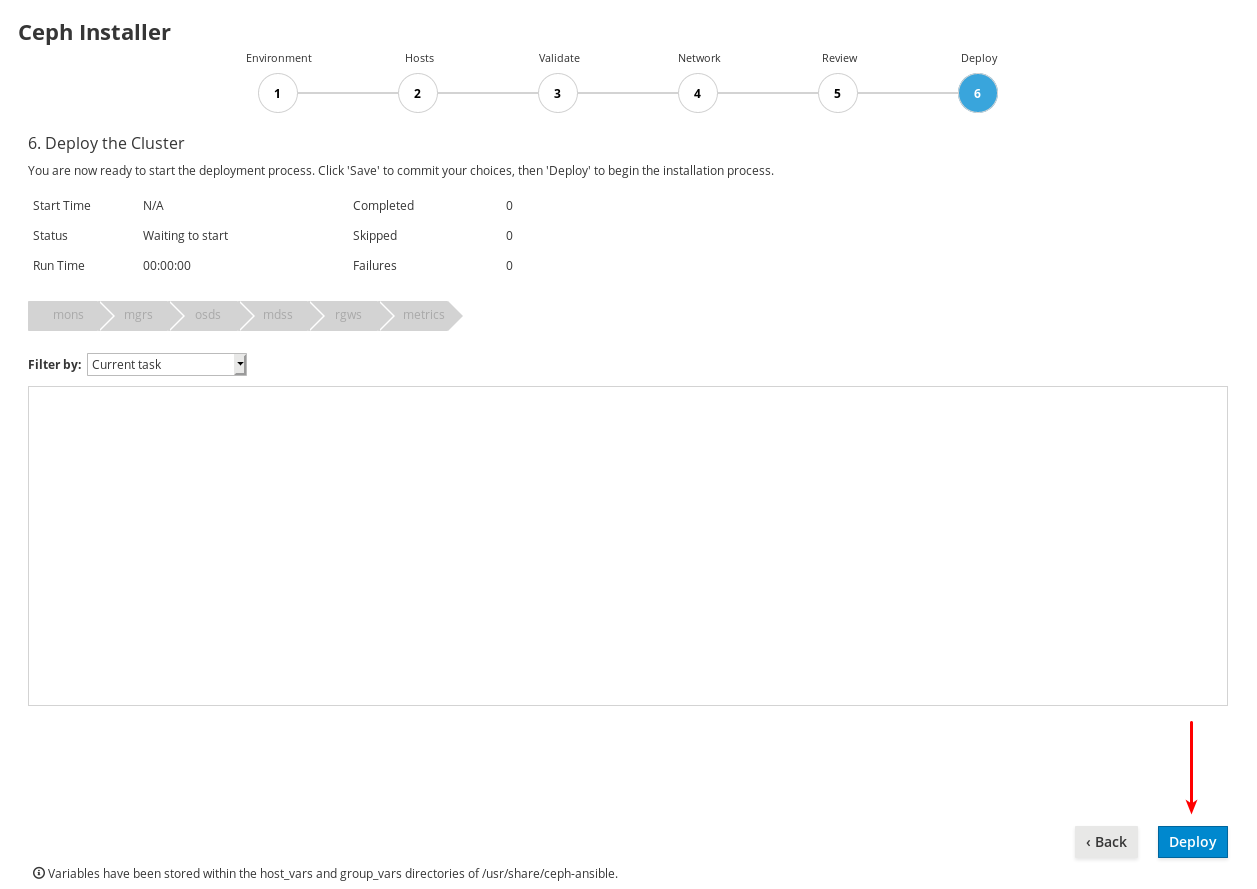

4.11. Ceph クラスターのデプロイ

Deploy ページを使用すると、インストール設定をネイティブの Ansible 形式で保存し、必要に応じてそれらの設定の確認または変更、インストールの開始、その進捗の監視、インストールが正常に完了した後にクラスターのステータスを表示することができます。

前提条件

- Review ページ でのインストール設定が検証済みである。

手順

ページの右下隅にある Save ボタンをクリックして、実際にインストールを実行するために Ansible が使用する Ansible Playbook にインストール設定を保存します。

-

必要に応じて、Ansible 管理ノードにある Ansible Playbook の設定を表示するか、カスタマイズします。Playbook は

/usr/share/ceph-ansibleにあります。Ansible Playbook の詳細と、これらを使用してインストールをカスタマイズする方法については、Red Hat Ceph Storage クラスターのインストール を参照してください。 -

Grafana およびダッシュボードのデフォルトユーザー名およびパスワードを保護します。Red Hat Ceph Storage 4.1 以降、

/usr/share/ceph-ansible/group_vars/all.ymlのdashboard_admin_passwordおよびgrafana_admin_passwordをコメント解除するか設定する必要があります。それぞれに安全なパスワードを設定します。dashboard_admin_userおよびgrafana_admin_userのカスタムユーザー名も設定します。 ページの右下隅にある Deploy ボタンをクリックして、インストールを開始します。

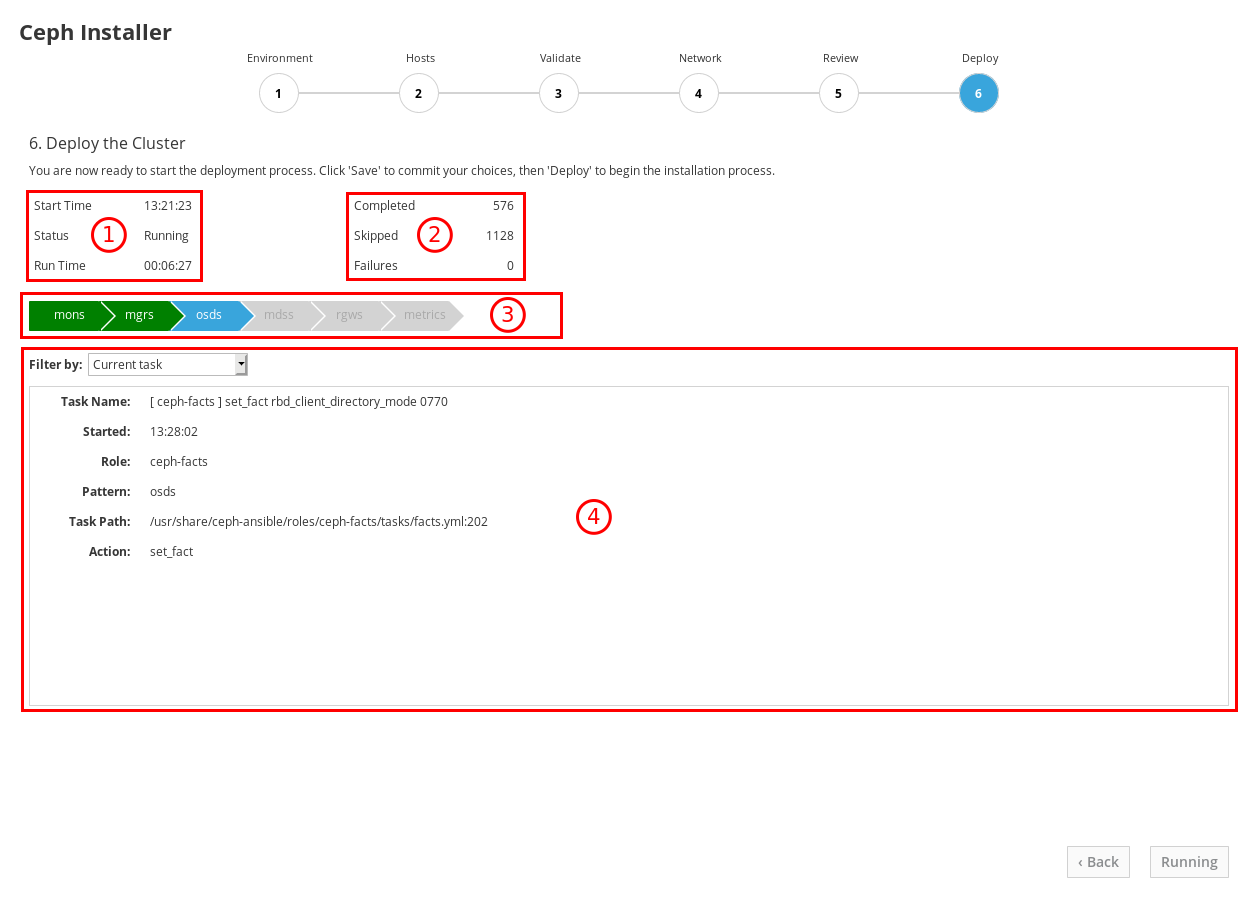

実行中のインストールの進捗を確認します。

1 にある情報は、インストールが実行しているかどうか、開始時間、および経過時間を示します。2 にある情報は、試行された Ansible タスクの概要を示しています。3 にある情報は、インストールされているロールまたはインストールしているロールを示しています。緑色は、そのロールに割り当てられたすべてのホストにそのロールがインストールされているロールを表します。青色は、ロールが割り当てられているホストが依然としてインストールされているロールを表します。4 の場合は、現在のタスクの詳細を表示したり、失敗したタスクを表示できます。Filter by メニューを使用して、現在のタスクと失敗したタスクを切り換えます。

ロール名は、Ansible インベントリーファイルから取得されます。

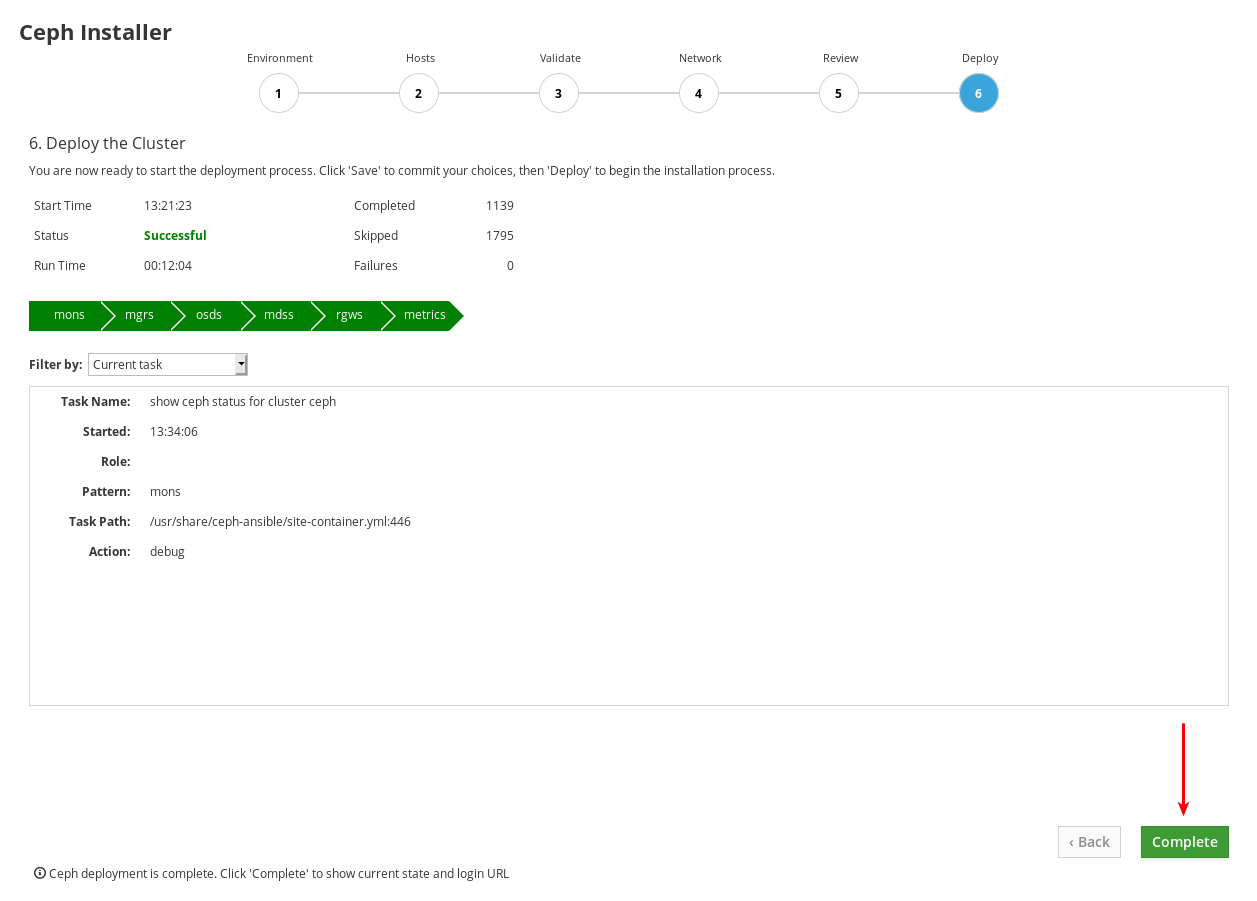

monsは Monitors で、mgrsは Managers で、osdは Object Storage Devices で、mdssはメタデータサーバーで、rgwsは RADOS ゲートウェイで、metricsはダッシュボードメトリックの Grafana および Prometheus サービスです。スクリーンショットの例には表示されません。iscsigwsは iSCSI ゲートウェイです。インストールが完了したら、ページの右下隅にある Complete ボタンをクリックします。これにより、

ceph statusコマンドの出力と Dashboard のアクセス情報を表示するウィンドウが開きます。

以下の例のクラスターステータス情報を、クラスターのクラスターステータス情報と比較します。この例では、すべての OSD が稼働中、およびすべてのサービスがアクティブな正常なクラスターを示しています。PG は、

active+clean状態です。クラスターの一部の要素が同一ではない場合は、トラブルシューティングガイド で問題の解決方法に関する情報を参照してください。

Ceph Cluster Status ウィンドウ下部に、URL、ユーザー名、パスワードなど、Dashboard のアクセス情報が表示されます。この情報を書き留めておいてください。

ダッシュボードにアクセス するには、ダッシュボードガイド と共に前のステップの情報を使用します。

ダッシュボードは Web インターフェイスを提供するので、Red Hat Ceph Storage クラスターを管理および監視することができます。詳細は、ダッシュボードガイド を参照してください。

-

オプション:

cockpit-ceph-installer.logファイルを表示します。このファイルは、作成された選択のログを記録し、生成されたプローブプロセスに関連する警告を記録します。これは、インストーラースクリプトを実行したユーザーのホームディレクトリーansible-runner-service.shにあります。

第5章 Ansible を使用した Red Hat Ceph Storage のインストール

本章では、Ansible アプリケーションを使用して Red Hat Ceph Storage クラスターおよびその他のコンポーネントをデプロイする方法を説明します (メタデータサーバーや Ceph Object Gateway など)。

- Red Hat Ceph Storage クラスターをインストールするには、「Red Hat Ceph Storage クラスターのインストール」 を参照してください。

- メタデータサーバーをインストールするには、「メタデータサーバーのインストール」 を参照してください。

-

ceph-clientロールをインストールするには、「Ceph クライアントロールのインストール」 を参照してください。 - Ceph Object Gateway をインストールするには、「Ceph Object Gateway のインストール」 を参照してください。

- マルチサイトの Ceph Object Gateway を設定するには、「マルチサイト Ceph Object Gateway の設定」 を参照してください。

-

Ansible の

--limitオプションについては、「limitオプションについて」 を参照してください。

5.1. 前提条件

- 有効なカスタマーサブスクリプションを取得します。

各ノードで以下の手順を実行してクラスターノードを準備します。

5.2. Red Hat Ceph Storage クラスターのインストール

Playbook ceph-ansible で Ansible アプリケーションを使用して、ベアメタルまたはコンテナーに Red Hat Ceph Storage をインストールします。実稼働環境で Ceph ストレージクラスターを使用するには、最小で 3 つの監視ノードと、複数の OSD デーモンが含まれる OSD ノードが必要です。通常、実稼働環境で実行されている一般的な Ceph ストレージクラスターは、10 台以上のノードで設定されます。

以下の手順では、特に指示しない限り、Ansible 管理ノードからコマンドを実行します。この手順は、指定しない限り、ベアメタルおよびコンテナーのデプロイメントの両方に適用されます。

Ceph はモニター 1 つで実行できますが、実稼働クラスターで高可用性を確保するためには、Red Hat は少なくとも 3 つのモニターノードを持つデプロイメントのみをサポートします。

Red Hat Ceph Storage 4 を Red Hat Enterprise Linux 7.7 のコンテナーにデプロイすると、Red Hat Ceph Storage 4 が Red Hat Enterprise Linux 8 コンテナーイメージにデプロイされます。

前提条件

- 有効なカスタマーサブスクリプションです。

- Ansible 管理ノードへのルートレベルのアクセス。

-

Ansible アプリケーションで使用する

ansibleユーザーアカウント。 - Red Hat Ceph Storage Tools および Ansible リポジトリーの有効化

- ISO インストールの場合は、Ansible ノードに最新の ISO イメージをダウンロードします。Red Hat Ceph Storage インストールガイドの Red Hat Ceph Storage リポジトリーの有効化 の章の ISO のインストールセクションを参照してください。

手順

-

Ansible 管理ノードで

rootユーザーアカウントとしてログインします。 すべてのデプロイメント (ベアメタル または コンテナー 内) については、

ceph-ansibleパッケージをインストールします。Red Hat Enterprise Linux 7

yum install ceph-ansible

[root@admin ~]# yum install ceph-ansibleCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 8

dnf install ceph-ansible

[root@admin ~]# dnf install ceph-ansibleCopy to Clipboard Copied! Toggle word wrap Toggle overflow /usr/share/ceph-ansibleディレクトリーに移動します。cd /usr/share/ceph-ansible

[root@admin ~]# cd /usr/share/ceph-ansibleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 新しい

ymlファイルを作成します。cp group_vars/all.yml.sample group_vars/all.yml cp group_vars/osds.yml.sample group_vars/osds.yml

[root@admin ceph-ansible]# cp group_vars/all.yml.sample group_vars/all.yml [root@admin ceph-ansible]# cp group_vars/osds.yml.sample group_vars/osds.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ベアメタル デプロイメント:

cp site.yml.sample site.yml

[root@admin ceph-ansible]# cp site.yml.sample site.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンテナー デプロイメント:

cp site-container.yml.sample site-container.yml

[root@admin ceph-ansible]# cp site-container.yml.sample site-container.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

新しいファイルを編集します。

group_vars/all.ymlファイルを編集するために開きます。重要カスタムストレージクラスター名の使用はサポートされていません。

clusterパラメーターにはceph以外の値を設定しないでください。カスタムストレージクラスター名は、librados、Ceph Object Gateway、RADOS ブロックデバイスミラーリングなどの Ceph クライアントでのみサポートされます。警告デフォルトでは、Ansible はインストール済みの再起動を試みますが、マスクされた

firewalldサービスにより、Red Hat Ceph Storage デプロイメントが失敗する可能性があります。この問題を回避するには、all.ymlファイルでconfigure_firewallオプションをfalseに設定します。firewalldサービスを実行している場合は、all.ymlファイルでconfigure_firewallオプションを使用する必要はありません。注記ceph_rhcs_versionオプションを4に設定すると、最新バージョンの Red Hat Ceph Storage 4 がプルされます。注記Red Hat は、

group_vars/all.ymlファイルでdashboard_enabledオプションをTrueに設定し、これをFalseに変更しないことを推奨します。Dashboard を無効にする場合には、Disabling the Ceph Dashboard を参照してください。注記Dashboard 関連のコンポーネントはコンテナー化されています。したがって、ベアメタル または コンテナー のデプロイメントでは、

ceph_docker_registry_usernameおよびceph_docker_registry_passwordのパラメーターを追加して、ceph-ansible が、ダッシュボードに必要なコンテナーイメージを取得できるようにする必要があります。注記Red Hat レジストリーサービスアカウントがない場合は、レジストリーサービスアカウントの Web ページ を使用して作成します。トークンの作成および管理方法に関する詳細は、ナレッジベースアーティクル Red Hat Container Registry Authentication を参照してください。

注記ceph_docker_registry_usernameおよびceph_docker_registry_passwordパラメーターにサービスアカウントを使用するだけでなく、カスタマーポータルの認証情報を使用することもできますが、ceph_docker_registry_passwordパラメーターを暗号化してセキュリティーを確保してください。詳細は、ansible-vault で Ansible のパスワード変数を暗号化する を参照してください。CDN インストール用の

all.ymlファイルの ベアメタル の例:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- これは、パブリックネットワーク上のインターフェイスです。

重要Red Hat Ceph Storage 4.1 以降、

/usr/share/ceph-ansible/group_vars/all.ymlのdashboard_admin_passwordおよびgrafana_admin_passwordをコメント解除するか設定する必要があります。それぞれに安全なパスワードを設定します。dashboard_admin_userおよびgrafana_admin_userのカスタムユーザー名も設定します。注記Red Hat Ceph Storage 4.2 で、インストールにローカルレジストリーを使用している場合は、Prometheus のイメージタグとして 4.6 を使用します。

ISO インストール

all.ymlファイルの ベアメタル の例:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- これは、パブリックネットワーク上のインターフェイスです。

all.ymlファイルの Containers の例:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- これは、パブリックネットワーク上のインターフェイスです。

重要Red Hat Ecosystem Catalog で最新のコンテナーイメージタグを検索し、最新のパッチが適用された最新のコンテナーイメージをインストールします。

デプロイメント中に Red Hat Ceph Storage ノードがインターネットにアクセスできない場合の、

all.ymlファイルの Containers の例:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- これは、パブリックネットワーク上のインターフェイスです。

- 置き換え

- LOCAL_NODE_FQDN を、ローカルホストの FQDN に置き換えます。

Red Hat Ceph Storage 4.2 からは、

dashboard_protocolはhttpsに設定されており、Ansible でダッシュボードと grafana の鍵と証明書が生成されます。ベアメタル または コンテナー デプロイメントでカスタム証明書の場合には、all.ymlファイルで、dashboard_crt、dashboard_key、grafana_crt、grafana_keyの Ansible インストーラーホストのパスを更新します。構文

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

http または https プロキシーで到達可能なコンテナーレジストリーを使用して Red Hat Ceph Storage をインストールするには、

group_vars/all.ymlファイルのceph_docker_http_proxyまたはceph_docker_https_proxy変数を設定します。例

ceph_docker_http_proxy: http://192.168.42.100:8080 ceph_docker_https_proxy: https://192.168.42.100:8080

ceph_docker_http_proxy: http://192.168.42.100:8080 ceph_docker_https_proxy: https://192.168.42.100:8080Copy to Clipboard Copied! Toggle word wrap Toggle overflow プロキシー設定で一部のホストを除外する必要がある場合は、

group_vars/all.ymlファイルでceph_docker_no_proxy変数を使用できます。例

ceph_docker_no_proxy: "localhost,127.0.0.1"

ceph_docker_no_proxy: "localhost,127.0.0.1"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Ceph Storage のプロキシーインストール用に

all.ymlファイルを編集する他に、/etc/environmentファイルを編集します。例

HTTP_PROXY: http://192.168.42.100:8080 HTTPS_PROXY: https://192.168.42.100:8080 NO_PROXY: "localhost,127.0.0.1"

HTTP_PROXY: http://192.168.42.100:8080 HTTPS_PROXY: https://192.168.42.100:8080 NO_PROXY: "localhost,127.0.0.1"Copy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、podman がトリガーされ、prometheus、grafana-server、alertmanager、node-exporter などのコンテナー化されたサービスを起動し、必要なイメージをダウンロードします。

全デプロイメントの場合には (ベアメタル または コンテナー)、

group_vars/osds.ymlファイルを編集します。重要オペレーティングシステムがインストールされているデバイスに OSD をインストールしないでください。オペレーティングシステムと OSD 間で同じデバイスを共有すると、パフォーマンスの問題が発生することになります。

ceph-ansible は

ceph-volumeツールを使用して、Ceph の使用に向けてストレージデバイスを準備します。ストレージデバイスを使用するようにosds.ymlを設定し、特定のワークロードのパフォーマンスを最適化することができます。重要以下の例では、BlueStore オブジェクトストアを使用します。これは、Ceph がデバイスにデータを保存するのに使用する形式です。以前のバージョンでは、Ceph は FileStore をオブジェクトストアとして使用していました。BlueStore はより多くの機能を提供し、パフォーマンスを向上させるため、この形式は Red Hat Ceph Storage 4.0 で非推奨になっています。FileStore は依然として使用できますが、Red Hat サポート例外が必要です。BlueStore の詳細は、Red Hat Ceph Storage アーキテクチャーガイド の Ceph BlueStore を参照してください。

自動検出

osd_auto_discovery: true

osd_auto_discovery: trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 上記の例では、システム上の空のストレージデバイスをすべて使用して OSD を作成するため、明示的に指定する必要はありません。この

ceph-volumeツールは、空のデバイスを確認するため、空ではないデバイスは使用されません。注記後で

purge-docker-cluster.ymlまたはpurge-cluster.ymlを使用してクラスターを削除する場合は、osd_auto_discoveryをコメントアウトし、osds.ymlファイルで OSD デバイスを宣言する必要があります。詳細については、Ansible によってデプロイされたストレージクラスターのパージ を参照してください。簡易設定

初回のシナリオ

devices: - /dev/sda - /dev/sdb

devices: - /dev/sda - /dev/sdbCopy to Clipboard Copied! Toggle word wrap Toggle overflow または、以下を実行します。

2 つ目のシナリオ

Copy to Clipboard Copied! Toggle word wrap Toggle overflow または、以下を実行します。

3 つ目のシナリオ

lvm_volumes: - data: /dev/sdb - data: /dev/sdc

lvm_volumes: - data: /dev/sdb - data: /dev/sdcCopy to Clipboard Copied! Toggle word wrap Toggle overflow または、以下を実行します。

4 つ目のシナリオ

lvm_volumes: - data: /dev/sdb - data:/dev/nvme0n1lvm_volumes: - data: /dev/sdb - data:/dev/nvme0n1Copy to Clipboard Copied! Toggle word wrap Toggle overflow devicesオプションのみを使用する場合には、ceph-volume lvm batchモードは OSD 設定を自動的に最適化します。最初のシナリオでは、

devicesを従来のハードドライブまたは SSD の場合には、デバイスごとに OSD が 1 つ作成されます。2 つ目のシナリオでは、従来のハードドライブと SSD が混在している場合、データは従来のハードドライブ (

sda、sdb) に配置され、BlueStore データベースは SSD (nvme0n1) にできる限り大きく作成されます。同様に、データは従来のハードドライブ (sdc、sdd) に配置され、デバイスの順序に関係なく、SSDnvme1n1に BlueStore データベースが作成されます。注記デフォルトでは、

ceph-ansibleではbluestore_block_db_sizeおよびbluestore_block_wal_sizeのデフォルト値は上書きされません。group_vars/all.ymlファイルのceph_conf_overridesを使用してbluestore_block_db_sizeを設定できます。bluestore_block_db_sizeの値は 2 GB より大きくする必要があります。3 つ目のシナリオでは、データは従来のハードドライブ (