オペレーションガイド

Red Hat Ceph Storage の操作タスク

概要

第1章 Ceph Orchestrator の紹介

ストレージ管理者として、Red Hat Ceph Storage クラスターでデバイスを検出し、サービスを作成する機能を提供する Ceph Orchestrator with Cephadm ユーティリティーを使用できます。

1.1. Ceph Orchestrator の使用

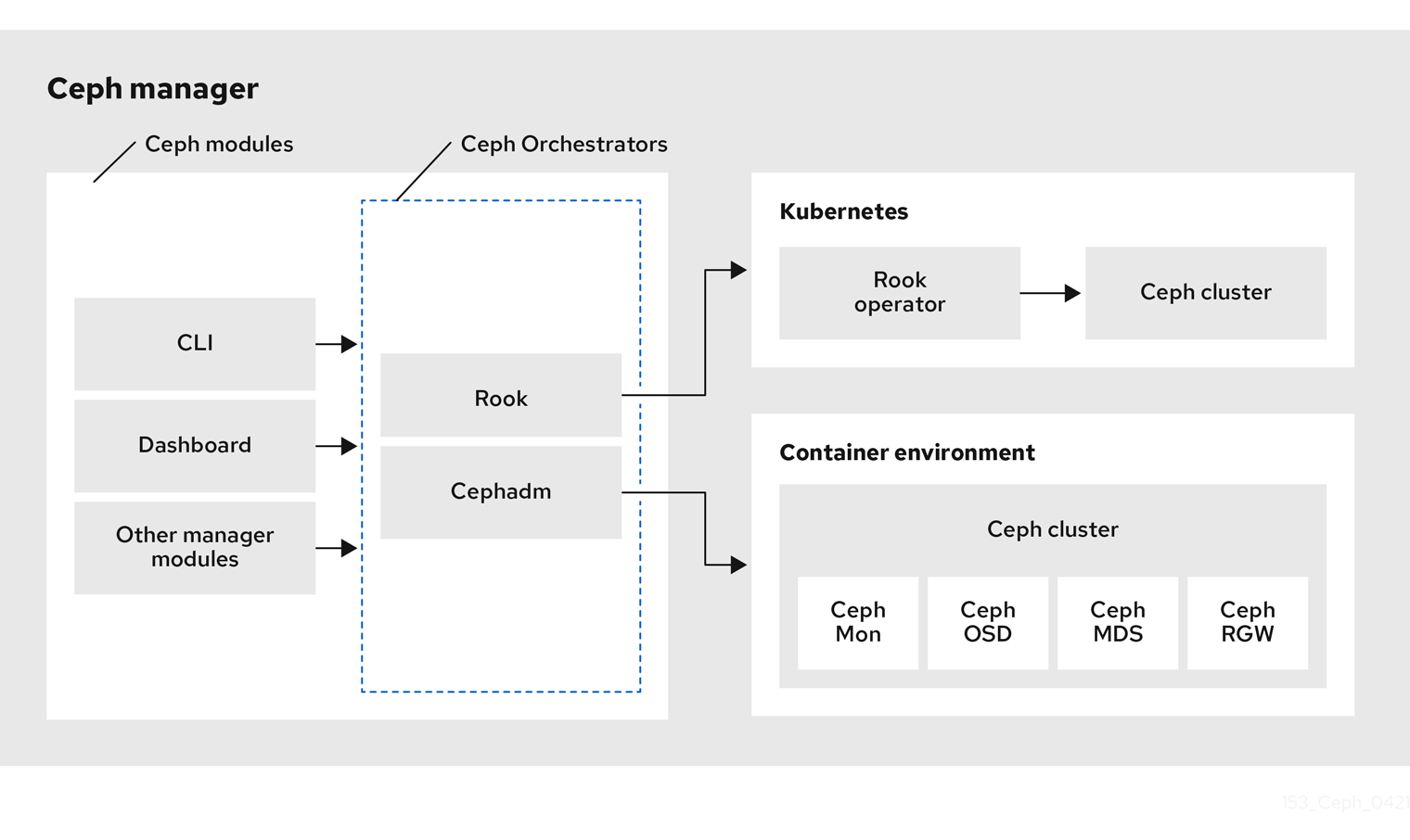

Red Hat Ceph Storage Orchestrators は、主に Red Hat Ceph Storage クラスターと、Rook や Cephadm などのデプロイメントツール間のブリッジとして機能するマネージャーモジュールです。また、Ceph コマンドラインインターフェイスおよび Ceph Dashboard と統合します。

以下は、Ceph Orchestrator のワークフローの図です。

Red Hat Ceph Storage Orchestrators の種類

Red Hat Ceph Storage Orchestrators には、主に 3 つのタイプがあります。

Orchestrator CLI : これらは Orchestrators で使用される一般的な API で、実装できるコマンドセットが含まれます。これらの API は、

ceph-mgrモジュールを外部オーケストレーションサービスとオーケストレートする一般的なコマンドラインインターフェイス (CLI) も提供しています。以下は、Ceph Orchestrator で使用される用語です。- ホスト: これは、物理ホストのホスト名で、コンテナー内の Pod 名、DNS 名、コンテナー名、またはホスト名ではありません。

- サービスタイプ: これは、nfs、mds、osd、mon、ragw、mgr、iscsi などのサービスのタイプです。

- サービス: モニターサービス、マネージャーサービス、OSD サービス、Ceph Object Gateway サービス、NFS サービスなど、Ceph Storage クラスターが提供する機能サービス。

- デーモン: Ceph Object Gateway サービスなどの 1 つ以上のホストによってデプロイされるサービスの特定のインスタンスでは、3 つの異なるホストで異なる Ceph Object Gateway デーモンを実行することができます。

Cephadm Orchestrator: これは、Rook または Ansible などの外部ツールに依存しない Ceph Orchestrator モジュールであり、SSH 接続を確立し、明示的な管理コマンドを実行することでクラスターのノードを管理します。このモジュールは Day One および Day Two 操作を対象としています。

Cephadm Orchestrator の使用は、Ansible などのデプロイメントフレームワークを使用せずに Ceph Storage クラスターをインストールする推奨方法です。これは、ストレージデバイスのインベントリーの作成、OSD のデプロイメントと交換、Ceph デーモンの起動と停止など、あらゆる管理操作を実行するために、クラスター内のすべてのノードに接続できる SSH 設定および鍵にアクセスできるマネージャーデーモンを提供するものです。さらに、Cephadm Orchestrator は、同一の場所に配置されたサービスの独立したアップグレードを可能にするために、

systemdによって管理されるコンテナーイメージをデプロイします。また、このオーケストレーターでは、Ceph Monitor および Ceph Manager を実行する最低限のクラスターをブートストラップするコマンドなど、現在のホストでコンテナーイメージベースのサービスのデプロイメントを管理するために、必要なすべての操作をカプセル化するツールが重要なポイントとなるでしょう。

Rook Orchestrator: Rook は、Kubernetes Rook operator を使用して Kubernetes クラスター内で実行される Ceph ストレージクラスターを管理するオーケストレーションツールです。rook モジュールは、Ceph の Orchestrator フレームワークと Rook との間の統合を提供します。Rook は、Kubernetes のオープンソースクラウドネイティブストレージ operator です。

Rook は operator モデルに従い、ここでは Ceph ストレージクラスターおよびその望ましい状態を記述するためにカスタムリソース定義 (CRD) オブジェクトが Kubernetes で定義されます。rook operator デーモンは、現在のクラスター状態と望ましい状態を比較する制御ループで実行され、それらを収束させるための手順を実行します。Ceph の望ましい状態を記述する主なオブジェクトは Ceph ストレージクラスター CRD で、どのデバイスが OSD によって消費されるか、実行すべきモニターの数、使用すべき Ceph バージョンなどの情報が含まれます。Rook は、RBD プール、CephFS ファイルシステムなどを記述するために他の複数の CRD を定義します。

Rook Orchestrator モジュールは、

ceph-mgrデーモンで実行されるグルーで、必要なクラスターの状態を記述する Kubernetes で Ceph ストレージクラスターに変更を加えて Ceph オーケストレーション API を実装します。Rook クラスターのceph-mgrデーモンは Kubernetes Pod として実行されているため、rook モジュールは明示的な設定がなくても Kubernetes API に接続できます。

第2章 Ceph Orchestrator を使用したサービスの管理

ストレージ管理者は、Red Hat Ceph Storage クラスターのインストール後に、Ceph Orchestrator を使用してストレージクラスターのサービスを監視および管理できます。サービスは、一緒に設定されるデーモンのグループです。

本セクションでは、以下の管理情報について説明します。

2.1. サービスステータスの確認

ceph orch ls コマンドを使用して、Red Hat Ceph Storage クラスターのサービスの以下のステータスを確認できます。

- サービスの一覧を出力します。

- ステータスを確認するサービスを見つけます。

- サービスのステータスを出力します。

ブートストラップ中にサービスが ceph orch apply コマンドで適用されると、サービス仕様ファイルの変更が複雑になります。代わりに、ceph orch ls コマンドで --export オプションを使用して実行中の仕様をエクスポートし、yaml ファイルを更新してサービスを再適用できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

-

Cephadmシェルにログインします。

手順

サービスの一覧を出力します。

構文

ceph orch ls [--service_type SERVICE_TYPE] [--service_name SERVICE_NAME] [--export] [--format FORMAT] [--refresh]

ceph orch ls [--service_type SERVICE_TYPE] [--service_name SERVICE_NAME] [--export] [--format FORMAT] [--refresh]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 形式は plain、

json、json-pretty、yaml、xml-pretty、またはxmlです。例

[ceph: root@host01 /]# ceph orch ls

[ceph: root@host01 /]# ceph orch lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 特定のサービスまたはデーモンのステータスを確認します。

構文

ceph orch ls [--service_type SERVICE_TYPE] [--service_name SERVICE_NAME] [--refresh]

ceph orch ls [--service_type SERVICE_TYPE] [--service_name SERVICE_NAME] [--refresh]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch ls --service-type mds [ceph: root@host01 /]# ceph orch ls --service-name rgw.realm.myzone

[ceph: root@host01 /]# ceph orch ls --service-type mds [ceph: root@host01 /]# ceph orch ls --service-name rgw.realm.myzoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow サービス仕様をエクスポートします。

例

[ceph: root@host01 /]# ceph orch ls --service-type mgr --export > mgr.yaml [ceph: root@host01 /]# ceph orch ls --export > cluster.yaml

[ceph: root@host01 /]# ceph orch ls --service-type mgr --export > mgr.yaml [ceph: root@host01 /]# ceph orch ls --export > cluster.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、ファイルが

.yamlファイル形式でエクスポートされます。このファイルは、単一のサービスのサービス仕様を取得するためにceph orch apply -iコマンドと併用できます。

2.2. デーモンステータスの確認

デーモンは、実行中の systemd ユニットで、サービスの一部です。

ceph orch ps コマンドを使用して、Red Hat Ceph Storage クラスターのデーモンの以下のステータスを確認できます。

- すべてのデーモンの一覧を出力します。

- ターゲットデーモンのステータスをクエリーします。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

-

Cephadmシェルにログインします。

手順

デーモンの一覧を出力します。

構文

ceph orch ps [--daemon-type DAEMON_TYPE] [--service_name SERVICE_NAME] [--daemon_id DAEMON_ID] [--format FORMAT] [--refresh]

ceph orch ps [--daemon-type DAEMON_TYPE] [--service_name SERVICE_NAME] [--daemon_id DAEMON_ID] [--format FORMAT] [--refresh]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch ps

[ceph: root@host01 /]# ceph orch psCopy to Clipboard Copied! Toggle word wrap Toggle overflow 特定のサービスインスタンスのステータスを確認します。

構文

ceph orch ls [--daemon-type DAEMON_TYPE] [--daemon_id DAEMON_ID] [--refresh]

ceph orch ls [--daemon-type DAEMON_TYPE] [--daemon_id DAEMON_ID] [--refresh]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch ps --daemon_type osd --daemon_id 0

[ceph: root@host01 /]# ceph orch ps --daemon_type osd --daemon_id 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. Ceph Orchestrator の配置仕様

Ceph Orchestrator を使用して、osds、mons、mgrs、mds、rgw、および iSCSI サービスをデプロイできます。Red Hat は、配置仕様を使用してサービスをデプロイすることを推奨します。Ceph Orchestrator を使用して、サービスをデプロイするためにデプロイする必要があるデーモンの場所と数を把握する必要があります。配置仕様は、コマンドライン引数または yaml ファイルのサービス仕様として渡すことができます。

配置仕様を使用してサービスをデプロイする方法は 2 つあります。

コマンドラインインターフェイスで配置仕様を直接使用します。たとえば、ホストに 3 つのモニターをデプロイする場合は、以下のコマンドを実行して

host01、host02、およびhost03に 3 つのモニターをデプロイします。例

[ceph: root@host01 /]# ceph orch apply mon --placement="3 host01 host02 host03"

[ceph: root@host01 /]# ceph orch apply mon --placement="3 host01 host02 host03"Copy to Clipboard Copied! Toggle word wrap Toggle overflow YAML ファイルでの配置仕様の使用。たとえば、すべてのホストに

node-exporterをデプロイする場合には、yamlファイルで以下を指定できます。例

service_type: node-exporter placement: host_pattern: '*'

service_type: node-exporter placement: host_pattern: '*'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4. コマンドラインインターフェイスを使用した Ceph デーモンのデプロイ

Ceph Orchestrator を使用すると、ceph orch コマンドを使用して Ceph Manager、Ceph Monitors、Ceph OSD、モニタリングスタックなどのデーモンをデプロイできます。配置仕様は、Orchestrator コマンドの --placement 引数として渡されます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ホストがストレージクラスターに追加されている。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のいずれかの方法を使用して、ホストにデーモンをデプロイします。

方法 1: デーモンの数とホスト名を指定します。

構文

ceph orch apply SERVICE_NAME --placement="NUMBER_OF_DAEMONS HOST_NAME_1 HOST_NAME_2 HOST_NAME_3"

ceph orch apply SERVICE_NAME --placement="NUMBER_OF_DAEMONS HOST_NAME_1 HOST_NAME_2 HOST_NAME_3"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch apply mon --placement="3 host01 host02 host03"

[ceph: root@host01 /]# ceph orch apply mon --placement="3 host01 host02 host03"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 方法 2: ラベルをホストに追加してから、ラベルを使用してデーモンをデプロイします。

ホストにラベルを追加します。

構文

ceph orch host label add HOSTNAME_1 LABEL

ceph orch host label add HOSTNAME_1 LABELCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch host label add host01 mon

[ceph: root@host01 /]# ceph orch host label add host01 monCopy to Clipboard Copied! Toggle word wrap Toggle overflow ラベルでデーモンをデプロイします。

構文

ceph orch apply DAEMON_NAME label:LABEL

ceph orch apply DAEMON_NAME label:LABELCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

ceph orch apply mon label:mon

ceph orch apply mon label:monCopy to Clipboard Copied! Toggle word wrap Toggle overflow

方法 3: ラベルをホストに追加し、

--placement引数を使用してデプロイします。ホストにラベルを追加します。

構文

ceph orch host label add HOSTNAME_1 LABEL

ceph orch host label add HOSTNAME_1 LABELCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch host label add host01 mon

[ceph: root@host01 /]# ceph orch host label add host01 monCopy to Clipboard Copied! Toggle word wrap Toggle overflow ラベルの配置仕様を使用してデーモンをデプロイします。

構文

ceph orch apply DAEMON_NAME --placement="label:LABEL"

ceph orch apply DAEMON_NAME --placement="label:LABEL"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

ceph orch apply mon --placement="label:mon"

ceph orch apply mon --placement="label:mon"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

サービスをリスト表示します。

例

[ceph: root@host01 /]# ceph orch ls

[ceph: root@host01 /]# ceph orch lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow ホスト、デーモン、およびプロセスをリスト表示します。

構文

ceph orch ps --daemon_type=DAEMON_NAME ceph orch ps --service_name=SERVICE_NAME

ceph orch ps --daemon_type=DAEMON_NAME ceph orch ps --service_name=SERVICE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch ps --daemon_type=mon [ceph: root@host01 /]# ceph orch ps --service_name=mon

[ceph: root@host01 /]# ceph orch ps --daemon_type=mon [ceph: root@host01 /]# ceph orch ps --service_name=monCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5. コマンドラインインターフェイスを使用したホストのサブセットへの Ceph デーモンのデプロイ

--placement オプションを使用して、ホストのサブセットにデーモンをデプロイできます。デーモンをデプロイするホストの名前で、配置仕様のデーモン数を指定できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ホストがクラスターに追加されている。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph デーモンをデプロイするホストをリスト表示します。

例

[ceph: root@host01 /]# ceph orch host ls

[ceph: root@host01 /]# ceph orch host lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow デーモンをデプロイします。

構文

ceph orch apply SERVICE_NAME --placement="NUMBER_OF_DAEMONS HOST_NAME_1 _HOST_NAME_2 HOST_NAME_3"

ceph orch apply SERVICE_NAME --placement="NUMBER_OF_DAEMONS HOST_NAME_1 _HOST_NAME_2 HOST_NAME_3"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

ceph orch apply mgr --placement="2 host01 host02 host03"

ceph orch apply mgr --placement="2 host01 host02 host03"Copy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

mgrデーモンは、2 つのホストにのみデプロイされます。

検証

ホストをリスト表示します。

例

[ceph: root@host01 /]# ceph orch host ls

[ceph: root@host01 /]# ceph orch host lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6. Ceph Orchestrator のサービス仕様

サービス仕様は、Ceph サービスのデプロイに使用されるサービス属性および設定を指定するデータ構造です。以下は、サービス仕様を指定するためのマルチドキュメント YAML ファイル cluster.yml の例になります。

例

以下は、サービス仕様のプロパティーが以下のように定義されるパラメーターのリストです。

service_type: サービスのタイプ- mon、crash、mds、mgr、osd、rbd、rbd-mirror などの Ceph サービス。

- nfs や rgw などの Ceph ゲートウェイ。

- Alertmanager、Prometheus、Grafana、または Node-exporter などのモニタリングスタック。

- カスタムコンテナーのコンテナー。

-

service_id: サービスの一意名 -

placement: これは、デーモンの場所とデプロイ方法を定義するために使用されます。 -

unmanaged:trueに設定すると、Orchestrator は、このサービスに関連付けられたデーモンをデプロイまたは削除しません。

Orchestrator のステートレスサービス

ステートレスサービスは、状態の情報を利用可能にする必要がないサービスです。たとえば、rgw サービスを起動するには、サービスの起動または実行に追加情報は必要ありません。rgw サービスは、機能を提供するためにこの状態に関する情報を作成しません。rgw サービスを開始されるタイミングに関係なく、状態は同じになります。

2.7. サービス仕様を使用した Ceph デーモンのデプロイ

Ceph Orchestrator を使用すると、YAML ファイルのサービス仕様を使用して Ceph Manager、Ceph Monitors、Ceph OSD、モニタリングスタックなどのデーモンをデプロイできます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- すべてのノードへの root レベルのアクセス。

手順

yamlファイルを作成します。例

touch mon.yaml

[root@host01 ~]# touch mon.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow このファイルは 2 つの方法で設定できます。

ファイルを編集して、配置仕様にホストの詳細を含めます。

構文

service_type: SERVICE_NAME placement: hosts: - HOST_NAME_1 - HOST_NAME_2service_type: SERVICE_NAME placement: hosts: - HOST_NAME_1 - HOST_NAME_2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを編集し、ラベルの詳細を配置仕様に含めます。

構文

service_type: SERVICE_NAME placement: label: "LABEL_1"

service_type: SERVICE_NAME placement: label: "LABEL_1"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

service_type: mon placement: label: "mon"

service_type: mon placement: label: "mon"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

オプション: サービスのデプロイ中に、CPU、CA 証明書、その他のファイルなどのサービス仕様ファイルで追加のコンテナー引数を使用することもできます。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow YAML ファイルをコンテナー内のディレクトリーにマウントします。

例

cephadm shell --mount mon.yaml:/var/lib/ceph/mon/mon.yaml

[root@host01 ~]# cephadm shell --mount mon.yaml:/var/lib/ceph/mon/mon.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow そのディレクトリーに移動します。

例

[ceph: root@host01 /]# cd /var/lib/ceph/mon/

[ceph: root@host01 /]# cd /var/lib/ceph/mon/Copy to Clipboard Copied! Toggle word wrap Toggle overflow サービス仕様を使用して Ceph デーモンをデプロイします。

構文

ceph orch apply -i FILE_NAME.yaml

ceph orch apply -i FILE_NAME.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 mon]# ceph orch apply -i mon.yaml

[ceph: root@host01 mon]# ceph orch apply -i mon.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

サービスをリスト表示します。

例

[ceph: root@host01 /]# ceph orch ls

[ceph: root@host01 /]# ceph orch lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow ホスト、デーモン、およびプロセスをリスト表示します。

構文

ceph orch ps --daemon_type=DAEMON_NAME

ceph orch ps --daemon_type=DAEMON_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch ps --daemon_type=mon

[ceph: root@host01 /]# ceph orch ps --daemon_type=monCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第3章 Ceph Orchestrator を使用したホストの管理

ストレージ管理者は、バックエンドで Cephadm で Ceph Orchestrator を使用し、既存の Red Hat Ceph Storage クラスターでホストを追加、リスト表示、および削除できます。

ホストにラベルを追加することもできます。ラベルは自由形式であり、特別な意味はありません。各ホストに複数のラベルを指定できます。たとえば、Monitor デーモンがデプロイされたすべてのホストに mon ラベルを適用し、Manager デーモンがデプロイされたすべてのホストに mgr を適用し、Ceph オブジェクトゲートウェイに rgw を適用します。

ストレージクラスター内のすべてのホストにラベルを付けると、各ホストで実行されているデーモンをすばやく識別できるため、システム管理タスクが簡素化されます。さらに、Ceph Orchestrator または YAML ファイルを使用して、特定のホストラベルを持つホストにデーモンをデプロイまたは削除できます。

本セクションでは、以下の管理タスクを説明します。

- Ceph Orchestrator を使用したホストの追加

- Ceph Orchestrator を使用した複数ホストの追加

- Ceph Orchestrator を使用したホストのリスト表示

- Ceph Orchestrator を使用したホストへのラベルの追加

- ホストからのラベルの削除。

- Ceph Orchestrator を使用したホストの削除

- Ceph Orchestrator を使用したホストのメンテナンスモード。

3.1. 前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- すべてのノードへの root レベルのアクセス。

-

新しいホストの IP アドレスは

/etc/hostsファイルで更新する必要があります。

3.2. Ceph Orchestrator を使用したホストの追加

バックエンドで Cephadm で Ceph Orchestrator を使用して、ホストを既存の Red Hat Ceph Storage クラスターに追加できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ストレージクラスター内のすべてのノードへの root レベルのアクセス。

- ノードを CDN に登録して、サブスクリプションを割り当てます。

-

ストレージクラスター内のすべてのノードへの sudo アクセスおよびパスワードなしの

sshアクセスのある Ansible ユーザー。

手順

Ceph 管理ノードから、Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow クラスターの SSH 公開鍵をフォルダーにデプロイメントします。

構文

ceph cephadm get-pub-key > ~/PATH

ceph cephadm get-pub-key > ~/PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph cephadm get-pub-key > ~/ceph.pub

[ceph: root@host01 /]# ceph cephadm get-pub-key > ~/ceph.pubCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph クラスターの SSH 公開鍵を、新たなホストの root ユーザーの

authorized_keysファイルにコピーします。構文

ssh-copy-id -f -i ~/PATH root@HOST_NAME_2

ssh-copy-id -f -i ~/PATH root@HOST_NAME_2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ssh-copy-id -f -i ~/ceph.pub root@host02

[ceph: root@host01 /]# ssh-copy-id -f -i ~/ceph.pub root@host02Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ansible 管理ノードから、新しいホストを Ansible インベントリーファイルに追加します。ファイルのデフォルトの場所は

/usr/share/cephadm-ansible/hosts/です。以下の例は、一般的なインベントリーファイルの構造を示しています。例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記以前に新しいホストを Ansible インベントリーファイルに追加し、ホストでプリフライト Playbook を実行している場合は、ステップ 6 に進みます。

--limitオプションを指定して、プリフライト Playbook を実行します。構文

ansible-playbook -i INVENTORY_FILE cephadm-preflight.yml --extra-vars "ceph_origin=rhcs" --limit NEWHOST

ansible-playbook -i INVENTORY_FILE cephadm-preflight.yml --extra-vars "ceph_origin=rhcs" --limit NEWHOSTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

ansible-playbook -i hosts cephadm-preflight.yml --extra-vars "ceph_origin=rhcs" --limit host02

[ceph-admin@admin cephadm-ansible]$ ansible-playbook -i hosts cephadm-preflight.yml --extra-vars "ceph_origin=rhcs" --limit host02Copy to Clipboard Copied! Toggle word wrap Toggle overflow プリフライト Playbook は、新しいホストに

podman、lvm2、chronyd、およびcephadmをインストールします。インストールが完了すると、cephadmは/usr/sbin/ディレクトリーに配置されます。Ceph 管理ノードから、Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow cephadmオーケストレーターを使用して、ストレージクラスターにホストを追加します。構文

ceph orch host add HOST_NAME IP_ADDRESS_OF_HOST [--label=LABEL_NAME_1,LABEL_NAME_2]

ceph orch host add HOST_NAME IP_ADDRESS_OF_HOST [--label=LABEL_NAME_1,LABEL_NAME_2]Copy to Clipboard Copied! Toggle word wrap Toggle overflow --labelオプションは任意です。これを使用すると、ホストの追加時にラベルが追加されます。ホストには複数のラベルを追加できます。例

[ceph: root@host01 /]# ceph orch host add host02 10.10.128.70 --labels=mon,mgr

[ceph: root@host01 /]# ceph orch host add host02 10.10.128.70 --labels=mon,mgrCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ホストをリスト表示します。

例

[ceph: root@host01 /]# ceph orch host ls

[ceph: root@host01 /]# ceph orch host lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3. ホストの初期 CRUSH ロケーションの設定

指定した階層にある新しい CRUSH ホストを作成するように cephadm tp に指示するホストに、location 識別子を追加できます。

location 属性は、最初の CRUSH の場所にのみ影響します。その後の location プロパティーの変更は無視されます。また、ホストを削除しても、CRUSH バケットは削除されません。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

手順

hosts.yamlファイルを編集し、以下の詳細を含めます。例

service_type: host hostname: host01 addr: 192.168.0.11 location: rack: rack1

service_type: host hostname: host01 addr: 192.168.0.11 location: rack: rack1Copy to Clipboard Copied! Toggle word wrap Toggle overflow YAML ファイルをコンテナー内のディレクトリーにマウントします。

例

cephadm shell --mount hosts.yaml:/var/lib/ceph/hosts.yaml

[root@host01 ~]# cephadm shell --mount hosts.yaml:/var/lib/ceph/hosts.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow そのディレクトリーに移動します。

例

[ceph: root@host01 /]# cd /var/lib/ceph/

[ceph: root@host01 /]# cd /var/lib/ceph/Copy to Clipboard Copied! Toggle word wrap Toggle overflow サービス仕様を使用してホストをデプロイします。

構文

ceph orch apply -i FILE_NAME.yaml

ceph orch apply -i FILE_NAME.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 ceph]# ceph orch apply -i hosts.yaml

[ceph: root@host01 ceph]# ceph orch apply -i hosts.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4. Ceph Orchestrator を使用した複数ホストの追加

YAML ファイル形式のサービス仕様の使用と同時に、Ceph Orchestrator を使用して複数のホストを Red Hat Ceph Storage クラスターに追加することができます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

手順

hosts.yamlファイルを作成します。例

touch hosts.yaml

[root@host01 ~]# touch hosts.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow hosts.yamlファイルを編集し、以下の詳細を含めます。例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow YAML ファイルをコンテナー内のディレクトリーにマウントします。

例

cephadm shell --mount hosts.yaml:/var/lib/ceph/hosts.yaml

[root@host01 ~]# cephadm shell --mount hosts.yaml:/var/lib/ceph/hosts.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow そのディレクトリーに移動します。

例

[ceph: root@host01 /]# cd /var/lib/ceph/

[ceph: root@host01 /]# cd /var/lib/ceph/Copy to Clipboard Copied! Toggle word wrap Toggle overflow サービス仕様を使用してホストをデプロイします。

構文

ceph orch apply -i FILE_NAME.yaml

ceph orch apply -i FILE_NAME.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 hosts]# ceph orch apply -i hosts.yaml

[ceph: root@host01 hosts]# ceph orch apply -i hosts.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ホストをリスト表示します。

例

[ceph: root@host01 /]# ceph orch host ls

[ceph: root@host01 /]# ceph orch host lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5. Ceph Orchestrator を使用したホストのリスト表示

Ceph クラスターのホストを Ceph Orchestrator で リスト表示できます。

ホストの STATUS は、ceph orch host ls コマンドの出力では空白になります。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ホストがストレージクラスターに追加されている。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow クラスターのホストをリスト表示します。

例

[ceph: root@host01 /]# ceph orch host ls

[ceph: root@host01 /]# ceph orch host lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow ホストの STATUS が空白であることを確認できます。これは想定内です。

3.6. Ceph Orchestrator を使用したホストへのラベルの追加

Ceph Orchestrator を使用して、既存の Red Hat Ceph Storage クラスター内のホストにラベルを追加できます。ラベルの例の一部は、ホストにデプロイされるサービスに基づいて、mgr、mon、および osd になります。

cephadm に特別な意味を持ち、_ で始まる以下のホストラベルを追加することもできます。

-

_no_schedule: このラベルは、cephadmがホスト上でデーモンをスケジュールまたはデプロイすることを阻止します。すでに Ceph デーモンが含まれている既存のホストに追加されると、これにより、cephadmは、自動的に削除されない OSD を除いて、それらのデーモンを別の場所に移動します。ホストに_no_scheduleラベルが追加されると、デーモンはそのホストにデプロイされません。ホストが削除される前にデーモンがドレインされると、そのホストに_no_scheduleラベルが設定されます。 -

_no_autotune_memory: このラベルは、ホスト上のメモリーを自動調整しません。そのホスト上の 1 つ以上のデーモンに対して、osd_memory_target_autotuneオプションまたは他の同様のオプションが有効になっている場合でも、デーモンメモリーが調整されることを阻止します。 -

_admin: デフォルトでは、_adminラベルはストレージクラスター内のブートストラップされたホストに適用され、client.adminキーは、ceph orch client-keyring {ls|set|rm}関数でそのホストに配布されるように設定されます。このラベルを追加のホストに追加すると、通常、cephadmは設定ファイルとキーリングファイルを/etc/cephにデプロイします。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ホストがストレージクラスターに追加される。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow ホストにラベルを追加します。

構文

ceph orch host label add HOST_NAME LABEL_NAME

ceph orch host label add HOST_NAME LABEL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch host label add host02 mon

[ceph: root@host01 /]# ceph orch host label add host02 monCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ホストをリスト表示します。

例

[ceph: root@host01 /]# ceph orch host ls

[ceph: root@host01 /]# ceph orch host lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.7. ホストからのラベルの削除

Ceph オーケストレーターを使用して、ホストからラベルを削除します。

前提条件

- インストールされ、ブートストラップされたストレージクラスター。

- ストレージクラスター内のすべてのノードへの root レベルのアクセス。

手順

cephadmシェルを起動します。cephadm shell [ceph: root@host01 /]#

[root@host01 ~]# cephadm shell [ceph: root@host01 /]#Copy to Clipboard Copied! Toggle word wrap Toggle overflow ラベルを削除します。

構文

ceph orch host label rm HOSTNAME LABEL

ceph orch host label rm HOSTNAME LABELCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch host label rm host02 mon

[ceph: root@host01 /]# ceph orch host label rm host02 monCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ホストをリスト表示します。

例

[ceph: root@host01 /]# ceph orch host ls

[ceph: root@host01 /]# ceph orch host lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.8. Ceph Orchestrator を使用したホストの削除

Ceph Orchestrator で、Ceph クラスターのホストを削除できます。すべてのデーモンは、_no_schedule ラベルを追加する drain オプションで削除され、操作が完了するまでデーモンまたはクラスターをデプロイメントできないようにします。

ブートストラップホストを削除する場合は、ホストを削除する前に、必ず管理キーリングと設定ファイルをストレージクラスター内の別のホストにコピーしてください。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- すべてのノードへの root レベルのアクセス。

- ホストがストレージクラスターに追加されている。

- すべてのサービスがデプロイされている。

- Cephadm が、サービスを削除する必要があるノードにデプロイされている。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow ホストの詳細を取得します。

例

[ceph: root@host01 /]# ceph orch host ls

[ceph: root@host01 /]# ceph orch host lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow ホストからすべてのデーモンをドレインします。

構文

ceph orch host drain HOSTNAME

ceph orch host drain HOSTNAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch host drain host02

[ceph: root@host01 /]# ceph orch host drain host02Copy to Clipboard Copied! Toggle word wrap Toggle overflow _no_scheduleラベルは、デプロイメントをブロックするホストに自動的に適用されます。OSD の削除のステータスを確認します。

例

[ceph: root@host01 /]# ceph orch osd rm status

[ceph: root@host01 /]# ceph orch osd rm statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow OSD に配置グループ (PG) が残っていない場合、OSD は廃止され、ストレージクラスターから削除されます。

ストレージクラスターからすべてのデーモンが削除されているかどうかを確認します。

構文

ceph orch ps HOSTNAME

ceph orch ps HOSTNAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch ps host02

[ceph: root@host01 /]# ceph orch ps host02Copy to Clipboard Copied! Toggle word wrap Toggle overflow ホストを削除。

構文

ceph orch host rm HOSTNAME

ceph orch host rm HOSTNAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch host rm host02

[ceph: root@host01 /]# ceph orch host rm host02Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.9. Ceph Orchestrator を使用したホストのメンテナンスモード

Ceph Orchestrator を使用して、ホストのメンテナンスモードを切り替えできます。ceph orch host maintenance enter コマンドは、systemd target を停止します。これにより、ホスト上のすべての Ceph デーモンが停止します。同様に、ceph orch host maintenance exit コマンドは systemd target を再起動し、Ceph デーモンは自動的に再起動します。

ホストがメンテナンス状態になると、オーケストレータは次のワークフローを採用します。

-

orch host ok-to stopコマンドを実行して、ホストの削除がデータの可用性に影響しないことを確認します。 -

ホストに Ceph OSD デーモンがある場合、ホストサブツリーに

nooutを適用して、計画されたメンテナンススロット中にデータ移行がトリガーされないようにします。 - Ceph ターゲットを停止して、すべてのデーモンを停止します。

-

ホストで

ceph targetを無効にして、再起動によって Ceph サービスが自動的に開始されないようにします。

メンテナンスを終了すると、上記の順序が逆になります。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- すべてのノードへの root レベルのアクセス。

- クラスターに追加されたホスト。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow ホストをメンテナンスモードにしたり、メンテナンスモードから解除したりできます。

ホストをメンテナンスモードにします。

構文

ceph orch host maintenance enter HOST_NAME [--force]

ceph orch host maintenance enter HOST_NAME [--force]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch host maintenance enter host02 --force

[ceph: root@host01 /]# ceph orch host maintenance enter host02 --forceCopy to Clipboard Copied! Toggle word wrap Toggle overflow --forceフラグを使用すると、ユーザーは警告を回避できますが、アラートは回避できません。ホストをメンテナンスモードから解除します。

構文

ceph orch host maintenance exit HOST_NAME

ceph orch host maintenance exit HOST_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch host maintenance exit host02

[ceph: root@host01 /]# ceph orch host maintenance exit host02Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ホストをリスト表示します。

例

[ceph: root@host01 /]# ceph orch host ls

[ceph: root@host01 /]# ceph orch host lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第4章 Ceph Orchestrator を使用したモニターの管理

ストレージ管理者は、配置仕様を使用して追加のモニターをデプロイし、サービス仕様を使用してモニターを追加し、サブネット設定にモニターを追加し、特定のホストにモニターを追加できます。さらに、Ceph Orchestrator を使用してモニターを削除できます。

デフォルトでは、一般的な Red Hat Ceph Storage クラスターには、3 つまたは 5 つのモニターデーモンが異なるホストにデプロイされます。

Red Hat は、クラスターに 5 つ以上のノードがある場合に、5 つのモニターをデプロイすることを推奨します。

Red Hat では、Ceph を OSP director とともにデプロイする場合、3 つのモニターをデプロイすることを推奨します。

Ceph は、クラスターの拡大とともにモニターデーモンを自動的にデプロイし、クラスターの縮小とともにモニターデーモンを自動的にスケールバックします。このような自動拡大および縮小のスムーズな実行は、適切なサブネット設定によります。

モニターノードまたはクラスター全体が単一のサブネットにある場合、Cephadm は新規ホストをクラスターに追加する際に最大 5 つのモニターデーモンを自動的を追加します。Cephadm は、新しいホストでモニターデーモンを自動的に設定します。新しいホストは、ストレージクラスターのブートストラップされたホストと同じサブネットにあります。

Cephadm はストレージクラスターのサイズの変更に対応するようモニターをデプロイし、スケーリングすることもできます。

4.1. Ceph Monitor

Ceph Monitor は、ストレージクラスターマップのマスターコピーを維持する軽量プロセスです。すべての Ceph クライアントは Ceph モニターに問い合わせ、ストレージクラスターマップの現在のコピーを取得し、クライアントがプールにバインドし、読み取りと書き込みを可能にします。

Ceph Monitor は Paxos プロトコルのバリエーションを使用して、ストレージクラスター全体でマップやその他の重要な情報について合意を確立します。Paxos の性質上、Ceph は、クォーラムを確立するためにモニターの大部分を実行する必要があり、合意を確立します。

Red Hat では、実稼働クラスターのサポートを受け取るために、別のホストで少なくとも 3 つのモニターが必要になります。

Red Hat は、奇数のモニターをデプロイすることを推奨します。奇数の Ceph モニターは、偶数のモニターよりも障害に対する回復性が高くなっています。たとえば、2 つのモニターデプロイメントでクォーラムを維持するには、Ceph は障害を許容できません。3 つのモニターでは障害を 1 つ、4 つのモニターでは障害を 1 つ、5 つのモニターでは障害を 2 つ許容します。このため、奇数も推奨されています。要約すると、Ceph は、モニターの大部分 (3 つのうち 2 つ、 4 つのうち 3 つなど) が実行され、相互に通信できるようにする必要があります。

マルチノードの Ceph ストレージクラスターの初回のデプロイには、Red Hat では 3 つのモニターが必要です。3 つ以上のモニターが有効な場合には、一度に数を 2 つ増やします。

Ceph Monitor は軽量であるため、OpenStack ノードと同じホストで実行できます。ただし、Red Hat は、別のホストでモニターを実行することを推奨します。

Red Hat は、コンテナー化された環境における Ceph サービスを共存させることのみをサポートしています。

ストレージクラスターからモニターを削除する場合、Ceph Monitor は Paxos プロトコルを使用して、マスターストレージクラスターマップに関する合意を確立することを検討してください。クォーラムを確立するには、十分な数の Ceph モニターが必要です。

4.2. モニタリング選択ストラテジーの設定

モニター選択ストラテジーは、ネット分割を識別し、障害を処理します。選択モニターストラテジーは、3 つの異なるモードで設定できます。

-

classic- これは、2 つのサイト間のエレクターモジュールに基づいて、最も低いランクのモニターが投票されるデフォルトのモードです。 -

disallow- このモードでは、モニターを不許可とマークできます。この場合、モニターはクォーラムに参加してクライアントにサービスを提供しますが、選出されたリーダーになることはできません。これにより、許可されていないリーダーのリストにモニターを追加できます。モニターが許可されていないリストにある場合、そのモニターは常に別のモニターに先送りされます。 -

connectivity- このモードは、主にネットワークの不一致を解決するために使用されます。各モニターがピアに対して提供する、liveness をチェックする ping に基づいて接続スコアを評価し、最も接続性が高く信頼性の高いモニターをリーダーに選択します。このモードは、クラスターが複数のデータセンターにまたがっている場合や影響を受けやすい場合に発生する可能性のあるネット分割を処理するように設計されています。このモードでは接続スコア評価が組み込まれ、最良スコアのモニターが選択されます。特定のモニターをリーダーにする必要がある場合は、特定のモニターがリスト内でランクが0の最初のモニターになるように選択ストラテジーを設定します。

他のモードで機能が必要でない限り、Red Hat は、classic モードに留まります。

クラスターを構築する前に、以下のコマンドで election_strategy を classic、disallow、または connectivity に変更します。

構文

ceph mon set election_strategy {classic|disallow|connectivity}

ceph mon set election_strategy {classic|disallow|connectivity}4.3. コマンドラインインターフェイスを使用した Ceph モニターデーモンのデプロイ

Ceph Orchestrator はデフォルトで 1 つのモニターデーモンをデプロイします。コマンドラインインターフェイスで placement 仕様を使用して、追加のモニターデーモンをデプロイできます。異なる数のモニターデーモンをデプロイするには、別の数を指定します。モニターデーモンがデプロイされるホストを指定しないと、Ceph Orchestrator はホストをランダムに選択し、モニターデーモンをそれらにデプロイします。

ストレッチモードでクラスターを使用している場合は、Ceph Monitor を追加する前に、crush_location を手動でモニターに追加します。

構文

ceph mon add HOST IP_ADDRESS datacenter=DATACENTER

ceph mon add HOST IP_ADDRESS datacenter=DATACENTER例

[ceph: root@host01 /]# ceph mon add host01 213.222.226.50 datacenter=DC1 adding mon.host01 at [v2:213.222.226.50:3300/0,v1:213.222.226.50:6789/0]

[ceph: root@host01 /]# ceph mon add host01 213.222.226.50 datacenter=DC1

adding mon.host01 at [v2:213.222.226.50:3300/0,v1:213.222.226.50:6789/0]

この例では、datacenter=DC1 は crush_location です。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ホストがクラスターに追加されている。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Ceph モニターデーモンをデプロイするには、以下の 4 つの方法があります。

方法 1

配置仕様を使用して、ホストにモニターをデプロイします。

注記Red Hat は

--placementオプションを使用して特定のホストにデプロイすることを推奨します。構文

ceph orch apply mon --placement="HOST_NAME_1 HOST_NAME_2 HOST_NAME_3"

ceph orch apply mon --placement="HOST_NAME_1 HOST_NAME_2 HOST_NAME_3"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch apply mon --placement="host01 host02 host03"

[ceph: root@host01 /]# ceph orch apply mon --placement="host01 host02 host03"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記コマンドの最初のノードとしてブートストラップノードが含まれるようにしてください。

重要モニターを個別に追加しないでください。

ceph orch apply monは置き換えを行うため、モニターはすべてのホストに追加されません。たとえば、以下のコマンドを実行すると、最初のコマンドがhost01にモニターを作成します。2 番目のコマンドは host1 のモニターの代わりにhost02にモニターを作成します。3 番目のコマンドはhost02のモニターの代わりにhost03にモニターを作成します。最終的には、3 番目のホストにのみモニターが存在することになります。ceph orch apply mon host01 ceph orch apply mon host02 ceph orch apply mon host03

# ceph orch apply mon host01 # ceph orch apply mon host02 # ceph orch apply mon host03Copy to Clipboard Copied! Toggle word wrap Toggle overflow

方法 2

配置仕様を使用して、ラベルの付いた特定ホストに特定数のモニターをデプロイします。

ホストにラベルを追加します。

構文

ceph orch host label add HOSTNAME_1 LABEL

ceph orch host label add HOSTNAME_1 LABELCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch host label add host01 mon

[ceph: root@host01 /]# ceph orch host label add host01 monCopy to Clipboard Copied! Toggle word wrap Toggle overflow デーモンをデプロイします。

構文

ceph orch apply mon --placement="HOST_NAME_1:mon HOST_NAME_2:mon HOST_NAME_3:mon"

ceph orch apply mon --placement="HOST_NAME_1:mon HOST_NAME_2:mon HOST_NAME_3:mon"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch apply mon --placement="host01:mon host02:mon host03:mon"

[ceph: root@host01 /]# ceph orch apply mon --placement="host01:mon host02:mon host03:mon"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

方法 3

配置仕様を使用して、特定ホストに特定数のモニターをデプロイします。

構文

ceph orch apply mon --placement="NUMBER_OF_DAEMONS HOST_NAME_1 HOST_NAME_2 HOST_NAME_3"

ceph orch apply mon --placement="NUMBER_OF_DAEMONS HOST_NAME_1 HOST_NAME_2 HOST_NAME_3"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch apply mon --placement="3 host01 host02 host03"

[ceph: root@host01 /]# ceph orch apply mon --placement="3 host01 host02 host03"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

方法 4

ストレージクラスターのホストにモニターデーモンを無作為にデプロイします。

構文

ceph orch apply mon NUMBER_OF_DAEMONS

ceph orch apply mon NUMBER_OF_DAEMONSCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch apply mon 3

[ceph: root@host01 /]# ceph orch apply mon 3Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

サービスをリスト表示します。

例

[ceph: root@host01 /]# ceph orch ls

[ceph: root@host01 /]# ceph orch lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow ホスト、デーモン、およびプロセスをリスト表示します。

構文

ceph orch ps --daemon_type=DAEMON_NAME

ceph orch ps --daemon_type=DAEMON_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch ps --daemon_type=mon

[ceph: root@host01 /]# ceph orch ps --daemon_type=monCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4. サービス仕様を使用した Ceph モニターデーモンのデプロイ

Ceph Orchestrator はデフォルトで 1 つのモニターデーモンをデプロイします。YAML 形式のファイルなどのサービス仕様を使用して、追加のモニターデーモンをデプロイできます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ホストがクラスターに追加されている。

手順

mon.yamlファイルを作成します。例

touch mon.yaml

[root@host01 ~]# touch mon.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow mon.ymlファイルを編集し、以下の詳細を含めます。構文

service_type: mon placement: hosts: - HOST_NAME_1 - HOST_NAME_2service_type: mon placement: hosts: - HOST_NAME_1 - HOST_NAME_2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

service_type: mon placement: hosts: - host01 - host02service_type: mon placement: hosts: - host01 - host02Copy to Clipboard Copied! Toggle word wrap Toggle overflow YAML ファイルをコンテナー内のディレクトリーにマウントします。

例

cephadm shell --mount mon.yaml:/var/lib/ceph/mon/mon.yaml

[root@host01 ~]# cephadm shell --mount mon.yaml:/var/lib/ceph/mon/mon.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow そのディレクトリーに移動します。

例

[ceph: root@host01 /]# cd /var/lib/ceph/mon/

[ceph: root@host01 /]# cd /var/lib/ceph/mon/Copy to Clipboard Copied! Toggle word wrap Toggle overflow モニターデーモンをデプロイします。

構文

ceph orch apply -i FILE_NAME.yaml

ceph orch apply -i FILE_NAME.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 mon]# ceph orch apply -i mon.yaml

[ceph: root@host01 mon]# ceph orch apply -i mon.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

サービスをリスト表示します。

例

[ceph: root@host01 /]# ceph orch ls

[ceph: root@host01 /]# ceph orch lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow ホスト、デーモン、およびプロセスをリスト表示します。

構文

ceph orch ps --daemon_type=DAEMON_NAME

ceph orch ps --daemon_type=DAEMON_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch ps --daemon_type=mon

[ceph: root@host01 /]# ceph orch ps --daemon_type=monCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5. Ceph Orchestrator を使用した特定ネットワークでのモニターデーモンのデプロイ

Ceph Orchestrator はデフォルトで 1 つのモニターデーモンをデプロイします。各モニターに IP アドレスまたは CIDR ネットワークを明示的に指定し、各モニターが配置される場所を制御できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ホストがクラスターに追加されている。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow 自動化されたモニターのデプロイメントを無効にします。

例

[ceph: root@host01 /]# ceph orch apply mon --unmanaged

[ceph: root@host01 /]# ceph orch apply mon --unmanagedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 特定ネットワーク上のホストにモニターをデプロイします。

構文

ceph orch daemon add mon HOST_NAME_1:IP_OR_NETWORK

ceph orch daemon add mon HOST_NAME_1:IP_OR_NETWORKCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch daemon add mon host03:10.1.2.123

[ceph: root@host01 /]# ceph orch daemon add mon host03:10.1.2.123Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

サービスをリスト表示します。

例

[ceph: root@host01 /]# ceph orch ls

[ceph: root@host01 /]# ceph orch lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow ホスト、デーモン、およびプロセスをリスト表示します。

構文

ceph orch ps --daemon_type=DAEMON_NAME

ceph orch ps --daemon_type=DAEMON_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch ps --daemon_type=mon

[ceph: root@host01 /]# ceph orch ps --daemon_type=monCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.6. Ceph Orchestrator を使用したモニターデーモンの削除

ホストからモニターデーモンを削除するには、他のホストにモニターデーモンを再デプロイします。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ホストがクラスターに追加されている。

- ホストにデプロイされたモニターデーモン 1 つ以上。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow ceph orch applyコマンドを実行して、必要なモニターデーモンをデプロイします。構文

ceph orch apply mon “NUMBER_OF_DAEMONS HOST_NAME_1 HOST_NAME_3”

ceph orch apply mon “NUMBER_OF_DAEMONS HOST_NAME_1 HOST_NAME_3”Copy to Clipboard Copied! Toggle word wrap Toggle overflow host02から monitor デーモンを削除する場合は、他のホストにモニターを再デプロイします。例

[ceph: root@host01 /]# ceph orch apply mon “2 host01 host03”

[ceph: root@host01 /]# ceph orch apply mon “2 host01 host03”Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ホスト、デーモン、およびプロセスをリスト表示します。

構文

ceph orch ps --daemon_type=DAEMON_NAME

ceph orch ps --daemon_type=DAEMON_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch ps --daemon_type=mon

[ceph: root@host01 /]# ceph orch ps --daemon_type=monCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.7. 異常なストレージクラスターからの Ceph Monitor の削除

正常でないストレージクラスターから、ceph-mon デーモンを削除できます。正常でないストレージクラスターとは、配置グループが永続的に active + clean 状態ではないストレージクラスターのことです。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Ceph Monitor ノードへの root レベルのアクセス。

- Ceph Monitor ノードが少なくとも 1 台実行している。

手順

存続しているモニターを特定し、ホストにログインします。

構文

ssh root@MONITOR_ID

ssh root@MONITOR_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

ssh root@host00

[root@admin ~]# ssh root@host00Copy to Clipboard Copied! Toggle word wrap Toggle overflow 各 Ceph Monitor ホストにログインし、すべての Ceph Monitor を停止します。

構文

cephadm unit --name DAEMON_NAME.HOSTNAME stop

cephadm unit --name DAEMON_NAME.HOSTNAME stopCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

cephadm unit --name mon.host00 stop

[root@host00 ~]# cephadm unit --name mon.host00 stopCopy to Clipboard Copied! Toggle word wrap Toggle overflow 拡張デーモンのメンテナンスに適した環境と、デーモンを対話的に実行するための環境を設定します。

構文

cephadm shell --name DAEMON_NAME.HOSTNAME

cephadm shell --name DAEMON_NAME.HOSTNAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

cephadm shell --name mon.host00

[root@host00 ~]# cephadm shell --name mon.host00Copy to Clipboard Copied! Toggle word wrap Toggle overflow monmapファイルのコピーを抽出します。構文

ceph-mon -i HOSTNAME --extract-monmap TEMP_PATH

ceph-mon -i HOSTNAME --extract-monmap TEMP_PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host00 /]# ceph-mon -i host01 --extract-monmap /tmp/monmap 2022-01-05T11:13:24.440+0000 7f7603bd1700 -1 wrote monmap to /tmp/monmap

[ceph: root@host00 /]# ceph-mon -i host01 --extract-monmap /tmp/monmap 2022-01-05T11:13:24.440+0000 7f7603bd1700 -1 wrote monmap to /tmp/monmapCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph Monitor 以外を削除します。

構文

monmaptool TEMPORARY_PATH --rm HOSTNAME

monmaptool TEMPORARY_PATH --rm HOSTNAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host00 /]# monmaptool /tmp/monmap --rm host01

[ceph: root@host00 /]# monmaptool /tmp/monmap --rm host01Copy to Clipboard Copied! Toggle word wrap Toggle overflow 削除されたモニターを含む存続しているモニターマップを、存続している Ceph モニターに挿入します。

構文

ceph-mon -i HOSTNAME --inject-monmap TEMP_PATH

ceph-mon -i HOSTNAME --inject-monmap TEMP_PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host00 /]# ceph-mon -i host00 --inject-monmap /tmp/monmap

[ceph: root@host00 /]# ceph-mon -i host00 --inject-monmap /tmp/monmapCopy to Clipboard Copied! Toggle word wrap Toggle overflow 存続しているモニターのみを起動します。

構文

cephadm unit --name DAEMON_NAME.HOSTNAME start

cephadm unit --name DAEMON_NAME.HOSTNAME startCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

cephadm unit --name mon.host00 start

[root@host00 ~]# cephadm unit --name mon.host00 startCopy to Clipboard Copied! Toggle word wrap Toggle overflow モニターがクォーラムを形成していることを確認します。

例

[ceph: root@host00 /]# ceph -s

[ceph: root@host00 /]# ceph -sCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

オプション: 削除された Ceph Monitor のデータディレクトリーを

/var/lib/ceph/CLUSTER_FSID/mon.HOSTNAMEディレクトリーにアーカイブします。

第5章 Ceph Orchestrator を使用したマネージャーの管理

ストレージ管理者は、Ceph Orchestrator を使用して追加のマネージャーデーモンをデプロイできます。Cephadm は、ブートストラッププロセス中にブートストラップノードにマネージャーデーモンを自動的にインストールします。

一般的に、同じレベルの可用性を実現するには、Ceph Monitor デーモンを実行している各ホストに Ceph Manager を設定する必要があります。

デフォルトでは、最初に起動した ceph-mgr インスタンスが Ceph Monitors によって有効になり、それ以外はスタンバイマネージャーになります。ceph-mgr デーモン間にクォーラムが存在する必要はありません。

アクティブデーモンが mon mgr beacon grace を超えてモニターに beacon を送信できない場合、スタンバイデーモンに置き換えられます。

フェイルオーバーを事前に回避する場合は、ceph mgr fail MANAGER_NAME コマンドを使用して、ceph-mgr デーモンを明示的に失敗としてマークできます。

5.1. 前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- すべてのノードへの root レベルのアクセス。

- ホストがクラスターに追加されている。

5.2. Ceph Orchestrator を使用したマネージャーデーモンのデプロイ

Ceph Orchestrator はデフォルトで 2 つの Manager デーモンをデプロイします。コマンドラインインターフェイスで placement 仕様を使用して、追加のマネージャーデーモンをデプロイできます。異なる数の Manager デーモンをデプロイするには、別の数を指定します。Manager デーモンがデプロイされるホストを指定しないと、Ceph Orchestrator はホストをランダムに選択し、Manager デーモンをそれらにデプロイします。

デプロイメントごとに少なくとも 3 つの Ceph Manager がデプロイメントに含まれるようにします。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ホストがクラスターに追加されている。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow - マネージャーデーモンをデプロイする方法は 2 つあります。

方法 1

特定のホストセットに配置仕様を使用してマネージャーデーモンをデプロイします。

注記Red Hat は

--placementオプションを使用して特定のホストにデプロイすることを推奨します。構文

ceph orch apply mgr --placement=" HOST_NAME_1 HOST_NAME_2 HOST_NAME_3"

ceph orch apply mgr --placement=" HOST_NAME_1 HOST_NAME_2 HOST_NAME_3"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch apply mgr --placement="host01 host02 host03"

[ceph: root@host01 /]# ceph orch apply mgr --placement="host01 host02 host03"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

方法 2

ストレージクラスターのホストにマネージャーデーモンを無作為にデプロイします。

構文

ceph orch apply mgr NUMBER_OF_DAEMONS

ceph orch apply mgr NUMBER_OF_DAEMONSCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch apply mgr 3

[ceph: root@host01 /]# ceph orch apply mgr 3Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

サービスをリスト表示します。

例

[ceph: root@host01 /]# ceph orch ls

[ceph: root@host01 /]# ceph orch lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow ホスト、デーモン、およびプロセスをリスト表示します。

構文

ceph orch ps --daemon_type=DAEMON_NAME

ceph orch ps --daemon_type=DAEMON_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch ps --daemon_type=mgr

[ceph: root@host01 /]# ceph orch ps --daemon_type=mgrCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3. Ceph Orchestrator を使用したマネージャーデーモンの削除

ホストからマネージャーデーモンを削除するには、他のホストにデーモンを再デプロイします。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- すべてのノードへの root レベルのアクセス。

- ホストがクラスターに追加されている。

- ホストにデプロイされたマネージャーデーモン 1 つ以上。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow ceph orch applyコマンドを実行して、必要なマネージャーデーモンを再デプロイします。構文

ceph orch apply mgr "NUMBER_OF_DAEMONS HOST_NAME_1 HOST_NAME_3"

ceph orch apply mgr "NUMBER_OF_DAEMONS HOST_NAME_1 HOST_NAME_3"Copy to Clipboard Copied! Toggle word wrap Toggle overflow host02からマネージャーデーモンを削除する場合は、他のホストにマネージャーデーモンを再デプロイします。例

[ceph: root@host01 /]# ceph orch apply mgr "2 host01 host03"

[ceph: root@host01 /]# ceph orch apply mgr "2 host01 host03"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ホスト、デーモン、およびプロセスをリスト表示します。

構文

ceph orch ps --daemon_type=DAEMON_NAME

ceph orch ps --daemon_type=DAEMON_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch ps --daemon_type=mgr

[ceph: root@host01 /]# ceph orch ps --daemon_type=mgrCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4. Ceph Manager モジュールの使用

ceph mgr module ls コマンドを使用して、使用可能なモジュールと現在有効になっているモジュールを確認します。

ceph mgr module enable MODULE コマンドまたは ceph mgr module enable MODULE コマンドを使用して、モジュールを有効または無効にします。

モジュールが有効になっている場合、アクティブな ceph-mgr デーモンがそれをロードして実行します。HTTP サーバーなどのサービスを提供するモジュールの場合、モジュールはロード時にアドレスを公開することがあります。このようなモジュールのアドレスを確認するには、ceph mgr services コマンドを実行します。

一部のモジュールでは、アクティブデーモンだけでなくスタンバイ ceph-mgr デーモンでも実行される特別なスタンバイモードを実装する場合もあります。これにより、クライアントがスタンバイに接続しようとした場合に、サービスを提供するモジュールがクライアントをアクティブデーモンにリダイレクトできるようになります。

以下はダッシュボードモジュールを有効にする例です。

クラスターの初回起動時に、mgr_initial_modules 設定を使用して、有効にするモジュールが上書きされます。ただし、この設定はクラスターの残りの有効期間中は無視されます。ブートストラップにのみ使用してください。たとえば、モニターデーモンを初めて起動する前に、ceph.conf ファイルに次のようなセクションを追加します。

[mon]

mgr initial modules = dashboard balancer

[mon]

mgr initial modules = dashboard balancerモジュールがコメント行フックを実装している場合、コマンドは通常の Ceph コマンドとしてアクセス可能であり、Ceph はモジュールコマンドを標準 CLI インターフェイスに自動的に組み込み、それらをモジュールに適切にルーティングします。

[ceph: root@host01 /]# ceph <command | help>

[ceph: root@host01 /]# ceph <command | help>上記のコマンドでは、次の設定パラメーターを使用できます。

| 設定 | 説明 | 型 | デフォルト |

|---|---|---|---|

|

| モジュールをロードするパス。 | String |

|

|

| デーモンデータをロードするパス (キーリングなど) | String |

|

|

| マネージャーの becon からモニターまでの間隔、およびその他の定期的なチェックの間隔 (秒数)。 | Integer |

|

|

| 最後の beacon からどれくらいの時間が経過すると、マネージャーは障害が発生したとみなさるか。 | Integer |

|

5.5. Ceph Manager バランサーモジュールの使用

バランサーは、Ceph Manager (ceph-mgr) のモジュールで、OSD 全体の配置グループ (PG) の配置を最適化することで、自動または監視された方法でバランスの取れた分散を実現します。

現在、バランサーモジュールを無効にできません。これをオフにして設定をカスタマイズすることしかできません。

モード

現在、サポートされるバランサーモードが 2 つあります。

crush-compat: CRUSH compat モードは、Ceph Luminous で導入された compat の

weight-set機能を使用して、CRUSH 階層のデバイスの別の重みセットを管理します。通常の重みは、デバイスに保存する目的のデータ量を反映するために、デバイスのサイズに設定したままにする必要があります。その後バランサーは、可能な限り目的のディストリビューションに一致するディストリビューションを達成するために、weight-setの値を少しずつ増減させ、値を最適化します。PG の配置は擬似ランダムプロセスであるため、配置には自然なばらつきが伴います。重みを最適化することで、バランサーはこの自然なばらつきに対応します。このモードは、古いクライアントと完全に後方互換性があります。OSDMap および CRUSH マップが古いクライアントと共有されると、バランサーは最適化された重みを実際の重みとして提示します。

このモードの主な制限は、階層のサブツリーが OSD を共有する場合に、バランサーが配置ルールの異なる複数の CRUSH 階層を処理できないことです。この設定では、共有 OSD での領域の使用を管理するのが困難になるため、一般的には推奨されません。そのため、通常、この制限は問題にはなりません。

upmap: Luminous 以降、OSDMap は、通常の CRUSH 配置計算への例外として、個々の OSD の明示的なマッピングを保存できます。これらの

upmapエントリーにより、PG マッピングを細かく制御できます。この CRUSH モードは、バランスの取れた分散を実現するために、個々の PG の配置を最適化します。多くの場合、この分散は各 OSD の PG 数 +/-1 PG で完璧です。これは割り切れない場合があるためです。重要この機能の使用を許可するには、次のコマンドを使用して、luminous 以降のクライアントのみをサポートする必要があることをクラスターに伝える必要があります。

[ceph: root@host01 /]# ceph osd set-require-min-compat-client luminous

[ceph: root@host01 /]# ceph osd set-require-min-compat-client luminousCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドは、luminous 以前のクライアントまたはデーモンがモニターに接続されていると失敗します。

既知の問題により、カーネル CephFS クライアントは自身を jewel クライアントとして報告します。この問題を回避するには、

--yes-i-really-mean-itフラグを使用します。[ceph: root@host01 /]# ceph osd set-require-min-compat-client luminous --yes-i-really-mean-it

[ceph: root@host01 /]# ceph osd set-require-min-compat-client luminous --yes-i-really-mean-itCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用しているクライアントのバージョンは、以下で確認できます。

[ceph: root@host01 /]# ceph features

[ceph: root@host01 /]# ceph featuresCopy to Clipboard Copied! Toggle word wrap Toggle overflow

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

手順

balancer モジュールが有効になっていることを確認します。

例

[ceph: root@host01 /]# ceph mgr module enable balancer

[ceph: root@host01 /]# ceph mgr module enable balancerCopy to Clipboard Copied! Toggle word wrap Toggle overflow balancer モジュールをオンにします。

例

[ceph: root@host01 /]# ceph balancer on

[ceph: root@host01 /]# ceph balancer onCopy to Clipboard Copied! Toggle word wrap Toggle overflow デフォルトのモードは

upmapです。モードは以下のように変更できます。例

[ceph: root@host01 /]# ceph balancer mode crush-compact

[ceph: root@host01 /]# ceph balancer mode crush-compactCopy to Clipboard Copied! Toggle word wrap Toggle overflow または

例

[ceph: root@host01 /]# ceph balancer mode upmap

[ceph: root@host01 /]# ceph balancer mode upmapCopy to Clipboard Copied! Toggle word wrap Toggle overflow

ステータス

バランサーの現在のステータスは、以下を実行していつでも確認できます。

例

[ceph: root@host01 /]# ceph balancer status

[ceph: root@host01 /]# ceph balancer status自動バランシング

デフォルトでは、バランサーモジュールをオンにする場合、自動分散が使用されます。

例

[ceph: root@host01 /]# ceph balancer on

[ceph: root@host01 /]# ceph balancer on以下を使用して、バランサーを再度オフにできます。

例

[ceph: root@host01 /]# ceph balancer off

[ceph: root@host01 /]# ceph balancer off

これには、古いクライアントと後方互換性があり、時間の経過とともにデータディストリビューションに小さな変更を加えて、OSD を同等に利用されるようにする crush-compat モードを使用します。

スロットリング

たとえば、OSD が失敗し、システムがまだ修復していない場合などに、クラスターのパフォーマンスが低下する場合は、PG ディストリビューションには調整は行われません。

クラスターが正常な場合、バランサーは変更を調整して、置き間違えた、または移動する必要のある PG の割合がデフォルトで 5% のしきい値を下回るようにします。この割合は、target_max_misplaced_ratio の設定を使用して調整できます。たとえば、しきい値を 7% に増やすには、次のコマンドを実行します。

例

[ceph: root@host01 /]# ceph config-key set mgr target_max_misplaced_ratio .07

[ceph: root@host01 /]# ceph config-key set mgr target_max_misplaced_ratio .07自動バランシングの場合:

- 自動バランサーの実行間におけるスリープ時間を秒単位で設定します。

例

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/sleep_interval 60

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/sleep_interval 60- 自動バランシングを開始する時刻を HHMM 形式で設定します。

例

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/begin_time 0000

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/begin_time 0000- 自動バランシングを終了する時刻を HHMM 形式で設定します。

例

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/end_time 2359

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/end_time 2359-

自動バランシングをこの曜日以降に制限します。

0は日曜日、1は月曜日というように、crontab と同じ規則を使用します。

例

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/begin_weekday 0

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/begin_weekday 0-

自動バランシングをこの曜日以前に制限します。

0は日曜日、1は月曜日というように、crontab と同じ規則を使用します。

例

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/end_weekday 6

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/end_weekday 6-

自動バランシングを制限するプール ID を定義します。これのデフォルトは空の文字列で、すべてのプールが均衡していることを意味します。数値のプール ID は、

ceph osd pool ls detailコマンドで取得できます。

例

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/pool_ids 1,2,3

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/pool_ids 1,2,3監視付き最適化

balancer 操作はいくつかの異なるフェーズに分類されます。

-

プランの構築。 -

現在の PG ディストリビューションまたは

プラン実行後に得られる PG ディストリビューションに対するデータ分散の品質の評価。 プランの実行。現在のディストリビューションを評価し、スコアを付けます。

例

[ceph: root@host01 /]# ceph balancer eval

[ceph: root@host01 /]# ceph balancer evalCopy to Clipboard Copied! Toggle word wrap Toggle overflow 単一プールのディストリビューションを評価するには、以下を実行します。

構文

ceph balancer eval POOL_NAME

ceph balancer eval POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph balancer eval rbd

[ceph: root@host01 /]# ceph balancer eval rbdCopy to Clipboard Copied! Toggle word wrap Toggle overflow 評価の詳細を表示するには、以下を実行します。

例

[ceph: root@host01 /]# ceph balancer eval-verbose ...

[ceph: root@host01 /]# ceph balancer eval-verbose ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 現在設定されているモードを使用してプランを生成するには、以下を実行します。

構文

ceph balancer optimize PLAN_NAME

ceph balancer optimize PLAN_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow PLAN_NAME は、カスタムプラン名に置き換えます。

例

[ceph: root@host01 /]# ceph balancer optimize rbd_123

[ceph: root@host01 /]# ceph balancer optimize rbd_123Copy to Clipboard Copied! Toggle word wrap Toggle overflow プランの内容を表示するには、以下を実行します。

構文

ceph balancer show PLAN_NAME

ceph balancer show PLAN_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph balancer show rbd_123

[ceph: root@host01 /]# ceph balancer show rbd_123Copy to Clipboard Copied! Toggle word wrap Toggle overflow 古いプランを破棄するには、以下を実行します。

構文

ceph balancer rm PLAN_NAME

ceph balancer rm PLAN_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph balancer rm rbd_123

[ceph: root@host01 /]# ceph balancer rm rbd_123Copy to Clipboard Copied! Toggle word wrap Toggle overflow 現在記録されているプランを表示するには、status コマンドを使用します。

[ceph: root@host01 /]# ceph balancer status

[ceph: root@host01 /]# ceph balancer statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow プラン実行後に生じるディストリビューションの品質を計算するには、以下を実行します。

構文

ceph balancer eval PLAN_NAME

ceph balancer eval PLAN_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph balancer eval rbd_123

[ceph: root@host01 /]# ceph balancer eval rbd_123Copy to Clipboard Copied! Toggle word wrap Toggle overflow プランを実行するには、以下を実行します。

構文

ceph balancer execute PLAN_NAME

ceph balancer execute PLAN_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph balancer execute rbd_123

[ceph: root@host01 /]# ceph balancer execute rbd_123Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記ディストリビューションの改善が想定される場合にのみ、プランを実行します。実行後、プランは破棄されます。

5.6. CephManager アラートモジュールの使用

Ceph Manager アラートモジュールを使用して、Red Hat Ceph Storage クラスターの健全性に関する簡単なアラートメッセージを電子メールで送信できます。

このモジュールは、堅牢な監視ソリューションを目的としたものではありません。Ceph クラスター自体の一部として実行されるため、ceph-mgr デーモンに障害が発生するとアラートが送信されないという根本的な制約があります。ただし、このモジュールは、既存の監視インフラストラクチャーが存在しない環境に存在するスタンドアロンクラスターには役立ちます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Ceph Monitor ノードへの root レベルのアクセス。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow アラートモジュールを有効にします。

例

[ceph: root@host01 /]# ceph mgr module enable alerts

[ceph: root@host01 /]# ceph mgr module enable alertsCopy to Clipboard Copied! Toggle word wrap Toggle overflow アラートモジュールが有効になっていることを確認します。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Simple Mail Transfer Protocol (SMTP) を設定します。

構文

ceph config set mgr mgr/alerts/smtp_host SMTP_SERVER ceph config set mgr mgr/alerts/smtp_destination RECEIVER_EMAIL_ADDRESS ceph config set mgr mgr/alerts/smtp_sender SENDER_EMAIL_ADDRESS

ceph config set mgr mgr/alerts/smtp_host SMTP_SERVER ceph config set mgr mgr/alerts/smtp_destination RECEIVER_EMAIL_ADDRESS ceph config set mgr mgr/alerts/smtp_sender SENDER_EMAIL_ADDRESSCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_host smtp.example.com [ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_destination example@example.com [ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_sender example2@example.com

[ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_host smtp.example.com [ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_destination example@example.com [ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_sender example2@example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: ポートを 465 に変更します。

構文

ceph config set mgr mgr/alerts/smtp_port PORT_NUMBER

ceph config set mgr mgr/alerts/smtp_port PORT_NUMBERCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_port 587

[ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_port 587Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要SSL は、Red Hat Ceph Storage 5 クラスターではサポートされていません。アラートの設定中に

smtp_sslパラメーターを設定しないでください。SMTP サーバーへの認証:

構文

ceph config set mgr mgr/alerts/smtp_user USERNAME ceph config set mgr mgr/alerts/smtp_password PASSWORD

ceph config set mgr mgr/alerts/smtp_user USERNAME ceph config set mgr mgr/alerts/smtp_password PASSWORDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_user admin1234 [ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_password admin1234

[ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_user admin1234 [ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_password admin1234Copy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: デフォルトでは、SMTP

From名はCephです。これを変更するには、smtp_from_nameパラメーターを設定します。構文

ceph config set mgr mgr/alerts/smtp_from_name CLUSTER_NAME

ceph config set mgr mgr/alerts/smtp_from_name CLUSTER_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_from_name 'Ceph Cluster Test'

[ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_from_name 'Ceph Cluster Test'Copy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: デフォルトでは、アラートモジュールはストレージクラスターの健全性を毎分チェックし、クラスターの健全ステータスに変更があった場合にメッセージを送信します。頻度を変更するには、

intervalパラメーターを設定します。構文

ceph config set mgr mgr/alerts/interval INTERVAL

ceph config set mgr mgr/alerts/interval INTERVALCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph config set mgr mgr/alerts/interval "5m"

[ceph: root@host01 /]# ceph config set mgr mgr/alerts/interval "5m"Copy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、間隔は 5 分に設定されています。

オプション: アラートをすぐに送信します。

例

[ceph: root@host01 /]# ceph alerts send

[ceph: root@host01 /]# ceph alerts sendCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.7. Ceph Manager クラッシュモジュールの使用

Ceph Manager クラッシュモジュールを使用すると、デーモンの crashdump に関する情報を収集し、これを Red Hat Ceph Storage クラスターに保存して詳細な分析を行うことができます。

デフォルトでは、デーモンの crashdump は /var/lib/ceph/crash にダンプされます。crash dir オプションを使用して設定できます。クラッシュディレクトリーの名前は、時間、日付、およびランダムに生成される UUID で名前が付けられ、同じ crash_id を持つメタデータファイルの meta と最近のログファイルが含まれます。

ceph-crash.service を使用して、これらのクラッシュを自動的に送信し、Ceph Monitor で永続化することができます。ceph-crash.service は crashdump ディレクトリーを監視し、それらを ceph crash post でアップロードします。

RECENT_CRASH ヘルスメッセージは、Ceph クラスター内の最も一般的なヘルスメッセージのいずれかとなります。このヘルスメッセージは、1 つ以上の Ceph デーモンが最近クラッシュし、そのクラッシュが管理者によってアーカイブまたは確認されていないことを意味します。これは、ソフトウェアのバグや、障害のあるディスクなどのハードウェアの問題があることを示している可能性があります。オプション mgr/crash/warn_recent_interval は、最新の方法の期間 (デフォルトでは 2 週間) を制御します。以下のコマンドを実行して警告を無効にすることができます。

例

[ceph: root@host01 /]# ceph config set mgr/crash/warn_recent_interval 0

[ceph: root@host01 /]# ceph config set mgr/crash/warn_recent_interval 0

mgr/crash/retain_interval オプションは、自動的にパージされるまでクラッシュレポートを保持する期間を制御します。このオプションのデフォルトは 1 年です。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

手順

crash モジュールが有効になっていることを確認します。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow クラッシュダンプの保存:

metaファイルは、メタとして crash ディレクトリーに保存されている JSON blob です。ceph コマンド-i -オプションを呼び出すことができます。これは、stdin から読み取ります。例

[ceph: root@host01 /]# ceph crash post -i meta

[ceph: root@host01 /]# ceph crash post -i metaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 新しいクラッシュ情報およびアーカイブされたすべてのクラッシュ情報のタイムスタンプまたは UUID クラッシュ ID を表示します。

例

[ceph: root@host01 /]# ceph crash ls

[ceph: root@host01 /]# ceph crash lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow すべての新規クラッシュ情報のタイムスタンプまたは UUID クラッシュ ID をリスト表示します。

例

[ceph: root@host01 /]# ceph crash ls-new

[ceph: root@host01 /]# ceph crash ls-newCopy to Clipboard Copied! Toggle word wrap Toggle overflow すべての新規クラッシュ情報のタイムスタンプまたは UUID クラッシュ ID をリスト表示します。

例

[ceph: root@host01 /]# ceph crash ls-new

[ceph: root@host01 /]# ceph crash ls-newCopy to Clipboard Copied! Toggle word wrap Toggle overflow 保存されたクラッシュ情報の概要を経過時間別にグループ化してリスト表示します。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 保存したクラッシュの詳細を表示します。

構文

ceph crash info CRASH_ID

ceph crash info CRASH_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow KEEP の日数より古い保存済みクラッシュを削除します。ここで、KEEP は整数である必要があります。

構文

ceph crash prune KEEP

ceph crash prune KEEPCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph crash prune 60

[ceph: root@host01 /]# ceph crash prune 60Copy to Clipboard Copied! Toggle word wrap Toggle overflow RECENT_CRASHヘルスチェックで考慮されなくなり、crash ls-newの出力に表示されないようにクラッシュレポートをアーカイブします。crash lsに表示されます。構文

ceph crash archive CRASH_ID

ceph crash archive CRASH_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph crash archive 2022-05-24T19:58:42.549073Z_b2382865-ea89-4be2-b46f-9a59af7b7a2d

[ceph: root@host01 /]# ceph crash archive 2022-05-24T19:58:42.549073Z_b2382865-ea89-4be2-b46f-9a59af7b7a2dCopy to Clipboard Copied! Toggle word wrap Toggle overflow すべてのクラッシュレポートをアーカイブします。

例

[ceph: root@host01 /]# ceph crash archive-all

[ceph: root@host01 /]# ceph crash archive-allCopy to Clipboard Copied! Toggle word wrap Toggle overflow クラッシュダンプを削除します。

構文

ceph crash rm CRASH_ID

ceph crash rm CRASH_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph crash rm 2022-05-24T19:58:42.549073Z_b2382865-ea89-4be2-b46f-9a59af7b7a2d

[ceph: root@host01 /]# ceph crash rm 2022-05-24T19:58:42.549073Z_b2382865-ea89-4be2-b46f-9a59af7b7a2dCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第6章 Ceph Orchestrator を使用した OSD の管理

ストレージ管理者は、Ceph Orchestrators を使用して Red Hat Ceph Storage クラスターの OSD を管理できます。

6.1. Ceph OSD

Red Hat Ceph Storage クラスターが稼働している場合は、ランタイム時に OSD をストレージクラスターに追加できます。

Ceph OSD は、通常 1 つのストレージドライブおよびノード内の関連付けられたジャーナル用に 1 つの ceph-osd デーモンで設定されます。ノードに複数のストレージドライブがある場合は、ドライブごとに 1 つの ceph-osd デーモンをマッピングします。

Red Hat は、クラスターの容量を定期的に確認して、ストレージ容量の最後に到達するかどうかを確認することを推奨します。ストレージクラスターが ほぼ完全 の比率に達すると、1 つ以上の OSD を追加してストレージクラスターの容量を拡張します。

Red Hat Ceph Storage クラスターのサイズを縮小したり、ハードウェアを置き換える場合は、ランタイム時に OSD を削除することも可能です。ノードに複数のストレージドライブがある場合には、そのドライブ用に ceph-osd デーモンのいずれかを削除する必要もあります。通常、ストレージクラスターの容量を確認して、容量の上限に達したかどうかを確認することが推奨されます。ストレージクラスターが ほぼ完全 の比率ではないことを OSD を削除する場合。

OSD を追加する前に、ストレージクラスターが 完全な 比率を超えないようにします。ストレージクラスターが ほぼ完全な 比率に達した後に OSD の障害が発生すると、ストレージクラスターが 完全な 比率を超過する可能性があります。Ceph は、ストレージ容量の問題を解決するまでデータを保護するための書き込みアクセスをブロックします。完全な 比率の影響を考慮せずに OSD を削除しないでください。

6.2. Ceph OSD ノードの設定

OSD を使用するプールのストレージストラテジーとして同様に Ceph OSD とサポートするハードウェアを設定します。Ceph は、一貫性のあるパフォーマンスプロファイルを確保するために、プール全体でハードウェアを統一します。最適なパフォーマンスを得るには、同じタイプまたはサイズのドライブのある CRUSH 階層を検討してください。

異なるサイズのドライブを追加する場合は、それに応じて重量を調整してください。OSD を CRUSH マップに追加する場合は、新規 OSD の重みを考慮してください。ハードドライブの容量は、1 年あたり約 40% 増加するため、新しい OSD ノードはストレージクラスターの古いノードよりも大きなハードドライブを持つ可能性があります。つまり、重みが大きくなる可能性があります。

新たにインストールを行う前に、Installation Guide のRequirements for Installing Red Hat Ceph Storageの章を確認します。

6.3. OSD メモリーの自動チューニング

OSD デーモンは、osd_memory_target 設定オプションに基づいてメモリー消費を調整します。osd_memory_target オプションは、システムで利用可能な RAM に基づいて OSD メモリーを設定します。

Red Hat Ceph Storage が他のサービスとメモリーを共有しない専用ノードにデプロイされている場合、cephadm は RAM の合計量とデプロイされた OSD の数に基づいて OSD ごとの消費を自動的に調整します。

デフォルトでは、Red Hat Ceph Storage 5.1 で osd_memory_target_autotune パラメーターは true に設定されます。

構文

ceph config set osd osd_memory_target_autotune true

ceph config set osd osd_memory_target_autotune true

OSD の追加や OSD の置き換えなど、クラスターのメンテナンスのためにストレージクラスターを Red Hat Ceph Storage 5.0 にアップグレードした後、Red Hat は osd_memory_target_autotune パラメーターを true に設定し、システムメモリーごとに osd メモリーを自動調整することを推奨します。

Cephadm は、mgr/cephadm/autotune_memory_target_ratio の割合で始まります。これはデフォルトでは、システムの合計 RAM 容量の 0.7 になります。これから、非 OSDS や osd_memory_target_autotune が false の OSD などの自動調整されないデーモンによって消費されるメモリー分を引き、残りの OSD で割ります。

デフォルトでは、autotune_memory_target_ratio は、ハイパーコンバージドインフラストラクチャーでは 0.2、その他の環境では 0.7 です。

osd_memory_target パラメーターは、以下のように計算されます。

構文

osd_memory_target = TOTAL_RAM_OF_THE_OSD_NODE (in Bytes) * (autotune_memory_target_ratio) / NUMBER_OF_OSDS_IN_THE_OSD_NODE - (SPACE_ALLOCATED_FOR_OTHER_DAEMONS (in Bytes))

osd_memory_target = TOTAL_RAM_OF_THE_OSD_NODE (in Bytes) * (autotune_memory_target_ratio) / NUMBER_OF_OSDS_IN_THE_OSD_NODE - (SPACE_ALLOCATED_FOR_OTHER_DAEMONS (in Bytes))SPACE_ALLOCATED_FOR_OTHER_DAEMONS には、任意で以下のデーモン領域の割り当てを含めることができます。

- Alertmanager: 1 GB

- Grafana: 1 GB

- Ceph Manager: 4 GB

- Ceph Monitor: 2 GB

- Node-exporter: 1 GB

- Prometheus: 1 GB

たとえば、ノードに OSD が 24 個あり、251 GB の RAM 容量がある場合、 osd_memory_target は 7860684936 になります。

最後のターゲットは、オプションとともに設定データベースに反映されます。MEM LIMIT 列の ceph orch ps の出力で、制限と各デーモンによって消費される現在のメモリーを確認できます。

Red Hat Ceph Storage 5.1 では、osd_memory_target_autotune のデフォルト設定 true は、コンピュートサービスと Ceph ストレージサービスが共存するハイパーコンバージドインフラストラクチャーでは適切ではありません。ハイパーコンバージドインフラストラクチャーでは、autotune_memory_target_ratio を 0.2 に設定して、Ceph のメモリー消費を減らすことができます。

例

[ceph: root@host01 /]# ceph config set mgr mgr/cephadm/autotune_memory_target_ratio 0.2

[ceph: root@host01 /]# ceph config set mgr mgr/cephadm/autotune_memory_target_ratio 0.2ストレージクラスターで OSD の特定のメモリーターゲットを手動で設定できます。

例

[ceph: root@host01 /]# ceph config set osd.123 osd_memory_target 7860684936

[ceph: root@host01 /]# ceph config set osd.123 osd_memory_target 7860684936ストレージクラスターで OSD ホストの特定のメモリーターゲットを手動で設定できます。

構文

ceph config set osd/host:HOSTNAME osd_memory_target TARGET_BYTES

ceph config set osd/host:HOSTNAME osd_memory_target TARGET_BYTES例

[ceph: root@host01 /]# ceph config set osd/host:host01 osd_memory_target 1000000000

[ceph: root@host01 /]# ceph config set osd/host:host01 osd_memory_target 1000000000

osd_memory_target_autotune を有効にすると、既存の手動の OSD メモリーターゲット設定が上書きされます。osd_memory_target_autotune オプションまたはその他の同様のオプションが有効になっている場合でもデーモンメモリーがチューニングされないようにするには、ホストに _no_autotune_memory ラベルを設定します。

構文

ceph orch host label add HOSTNAME _no_autotune_memory

ceph orch host label add HOSTNAME _no_autotune_memory自動チューニングオプションを無効にし、特定のメモリーターゲットを設定して、OSD をメモリー自動チューニングから除外できます。

例

[ceph: root@host01 /]# ceph config set osd.123 osd_memory_target_autotune false [ceph: root@host01 /]# ceph config set osd.123 osd_memory_target 16G

[ceph: root@host01 /]# ceph config set osd.123 osd_memory_target_autotune false

[ceph: root@host01 /]# ceph config set osd.123 osd_memory_target 16G6.4. Ceph OSD デプロイメント用のデバイスのリスト表示

Ceph Orchestrator を使用して OSD をデプロイする前に、利用可能なデバイスのリストを確認することができます。コマンドは、Cephadm によって検出可能なデバイスのリストを出力するために使用されます。以下の条件がすべて満たされると、ストレージデバイスが利用可能であるとみなされます。

- デバイスにはパーティションがない。

- デバイスは LVM 状態でない。

- デバイスをマウントしてはいけない。

- デバイスにはファイルシステムを含めることはできない。

- デバイスには Ceph BlueStore OSD を含めることはできない。

- デバイスは 5 GB を超える必要がある。

Ceph は、利用できないデバイスに OSD をプロビジョニングしません。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ホストがクラスターに追加されている。

- すべてのマネージャーおよびモニターデーモンがデプロイされている。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow OSD をデプロイするために利用可能なデバイスをリスト表示します。

構文

ceph orch device ls [--hostname=HOSTNAME_1 HOSTNAME_2] [--wide] [--refresh]

ceph orch device ls [--hostname=HOSTNAME_1 HOSTNAME_2] [--wide] [--refresh]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch device ls --wide --refresh

[ceph: root@host01 /]# ceph orch device ls --wide --refreshCopy to Clipboard Copied! Toggle word wrap Toggle overflow --wideオプションを使用すると、デバイスが OSD として使用できない可能性がある理由など、デバイスに関連するすべての詳細が提供されます。このオプションは、NVMe デバイスをサポートしません。任意手順:

ceph orch device lsの出力で Health、Ident および Fault フィールドを有効にするには、以下のコマンドを実行します。注記これらのフィールドは

libstoragemgmtライブラリーによってサポートされ、現時点では SCSI、SAS、SATA デバイスをサポートします。Cephadm シェルの外部で root ユーザーとして、ハードウェアと

libstoragemgmtライブラリーとの互換性を確認して、サービスの予期しない中断を回避します。例

cephadm shell lsmcli ldl

[root@host01 ~]# cephadm shell lsmcli ldlCopy to Clipboard Copied! Toggle word wrap Toggle overflow この出力で、それぞれの SCSI VPD 0x83 ID で Health Status が Good と表示されます。

注記この情報を取得しないと、フィールドを有効にした場合にデバイスで異常な挙動が発生する可能性があります。

Cephadm シェルに再度ログインし、

libstoragemgmtサポートを有効にします。例

cephadm shell [ceph: root@host01 /]# ceph config set mgr mgr/cephadm/device_enhanced_scan true

[root@host01 ~]# cephadm shell [ceph: root@host01 /]# ceph config set mgr mgr/cephadm/device_enhanced_scan trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow これが有効化されると、

ceph orch device lsを実行した場合、Health フィールドの出力は Good になります。

検証

デバイスをリスト表示します。

例

[ceph: root@host01 /]# ceph orch device ls

[ceph: root@host01 /]# ceph orch device lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.5. Ceph OSD デプロイメントのデバイスの消去

OSD をデプロイする前に、利用可能なデバイスのリストを確認する必要があります。デバイスに空き容量がない場合は、そのデバイスを消去してデバイス上のデータを消去します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ホストがクラスターに追加されている。

- すべてのマネージャーおよびモニターデーモンがデプロイされている。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow OSD をデプロイするために利用可能なデバイスをリスト表示します。

構文

ceph orch device ls [--hostname=HOSTNAME_1 HOSTNAME_2] [--wide] [--refresh]

ceph orch device ls [--hostname=HOSTNAME_1 HOSTNAME_2] [--wide] [--refresh]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch device ls --wide --refresh

[ceph: root@host01 /]# ceph orch device ls --wide --refreshCopy to Clipboard Copied! Toggle word wrap Toggle overflow デバイスのデータをクリアします。

構文

ceph orch device zap HOSTNAME FILE_PATH --force

ceph orch device zap HOSTNAME FILE_PATH --forceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch device zap host02 /dev/sdb --force

[ceph: root@host01 /]# ceph orch device zap host02 /dev/sdb --forceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

デバイスに容量があることを確認します。

例

[ceph: root@host01 /]# ceph orch device ls

[ceph: root@host01 /]# ceph orch device lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Available の下のフィールドが Yes であることを確認できます。

6.6. すべての利用可能なデバイスへの Ceph OSD のデプロイ

すべての OSDS を利用可能なすべてのデバイスにデプロイできます。Cephadm により、Ceph Orchestrator は利用可能な未使用のストレージデバイスで OSD を検出およびデプロイできます。使用可能なすべてのデバイスに OSD をデプロイメントするには、unmanaged パラメーターを指定せずにコマンドを実行し、その後 OSD が作成されないようにパラメーターを指定してコマンドを再実行します。

--all-available-devices を使用した OSD のデプロイメントは、通常、小規模なクラスターに使用されます。大規模なクラスターの場合は、OSD 仕様ファイルを使用します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ホストがクラスターに追加されている。

- すべてのマネージャーおよびモニターデーモンがデプロイされている。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow OSD をデプロイするために利用可能なデバイスをリスト表示します。

構文

ceph orch device ls [--hostname=HOSTNAME_1 HOSTNAME_2] [--wide] [--refresh]

ceph orch device ls [--hostname=HOSTNAME_1 HOSTNAME_2] [--wide] [--refresh]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch device ls --wide --refresh

[ceph: root@host01 /]# ceph orch device ls --wide --refreshCopy to Clipboard Copied! Toggle word wrap Toggle overflow すべての利用可能なデバイスに OSD をデプロイします。

例

[ceph: root@host01 /]# ceph orch apply osd --all-available-devices

[ceph: root@host01 /]# ceph orch apply osd --all-available-devicesCopy to Clipboard Copied! Toggle word wrap Toggle overflow ceph orch applyの影響は永続的であり、Orchestrator は自動的にデバイスを見つけ、それをクラスターに追加し、新しい OSD を作成します。これは、以下の条件下で実行されます。- 新しいディスクまたはドライブがシステムに追加される。

- 既存のディスクまたはドライブは消去される。

OSD は削除され、デバイスは消去される。

--unmanagedパラメーターを使用して、利用可能なすべてのデバイスで OSD の自動作成を無効にできます。例

[ceph: root@host01 /]# ceph orch apply osd --all-available-devices --unmanaged=true

[ceph: root@host01 /]# ceph orch apply osd --all-available-devices --unmanaged=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow パラメーター

--unmanagedをtrueに設定すると、OSD の作成が無効になり、新しい OSD サービスを適用しても変更はありません。注記コマンド

ceph orch daemon addは、新しい OSD を作成しますが、OSD サービスを追加しません。

検証

サービスをリスト表示します。

例

[ceph: root@host01 /]# ceph orch ls

[ceph: root@host01 /]# ceph orch lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow ノードとデバイスの詳細を表示します。

例

[ceph: root@host01 /]# ceph osd tree

[ceph: root@host01 /]# ceph osd treeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.7. 特定のデバイスおよびホストへの Ceph OSD のデプロイ

Ceph Orchestrator を使用して、特定のデバイスおよびホストにすべての Ceph OSD をデプロイできます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ホストがクラスターに追加されている。

- すべてのマネージャーおよびモニターデーモンがデプロイされている。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow OSD をデプロイするために利用可能なデバイスをリスト表示します。

構文

ceph orch device ls [--hostname=HOSTNAME_1 HOSTNAME_2] [--wide] [--refresh]

ceph orch device ls [--hostname=HOSTNAME_1 HOSTNAME_2] [--wide] [--refresh]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch device ls --wide --refresh

[ceph: root@host01 /]# ceph orch device ls --wide --refreshCopy to Clipboard Copied! Toggle word wrap Toggle overflow 特定のデバイスおよびホストに OSD をデプロイします。

構文

ceph orch daemon add osd HOSTNAME:DEVICE_PATH

ceph orch daemon add osd HOSTNAME:DEVICE_PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch daemon add osd host02:/dev/sdb

[ceph: root@host01 /]# ceph orch daemon add osd host02:/dev/sdbCopy to Clipboard Copied! Toggle word wrap Toggle overflow LVM レイヤーを使用せずに raw 物理デバイスに ODS をデプロイするには、

--method rawオプションを使用します。構文

ceph orch daemon add osd --method raw HOSTNAME:DEVICE_PATH

ceph orch daemon add osd --method raw HOSTNAME:DEVICE_PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch daemon add osd --method raw host02:/dev/sdb

[ceph: root@host01 /]# ceph orch daemon add osd --method raw host02:/dev/sdbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記別の DB または WAL デバイスがある場合、ブロックと DB デバイスまたは WAL デバイスの比率は 1:1 でなければなりません。

検証

サービスをリスト表示します。

例

[ceph: root@host01 /]# ceph orch ls osd