Dashboard ガイド

Ceph Dashboard を使用した Ceph クラスターのモニタリング

概要

第1章 Ceph Dashboard の概要

ストレージ管理者は、Red Hat Ceph Storage Dashboard は管理機能および監視機能を提供します。これにより、クラスターの管理および設定が可能になり、それに関連する情報およびパフォーマンス統計を可視化を可能にします。ダッシュボードは、ceph-mgr デーモンがホストする Web サーバーを使用します。

ダッシュボードは Web ブラウザーからアクセスでき、たとえばマネージャーモジュールの設定や OSD の状態の監視などの有用な管理機能および監視機能が含まれます。

Ceph Dashboard には、次の機能があります。

- マルチユーザーとロール管理

ダッシュボードは、権限とロールが異なる複数のユーザーアカウントをサポートします。ユーザーアカウントとロールは、コマンドラインと Web ユーザーインターフェイスの両方を使用して管理できます。ダッシュボードは、パスワードセキュリティーの強化に向けたさまざまな方法をサポートしています。ユーザーは最初のログイン後または設定可能な期間の後にパスワードを変更する必要があるなど、パスワードの複雑性ルールは設定できます。

詳細は、Ceph Dashboard でのロールの管理 および Ceph Dashboard でのユーザーの管理 を参照してください。

- シングルサインオン (SSO)

ダッシュボードは、SAML 2.0 プロトコルを使用した外部 ID プロバイダーとの認証をサポートしています。

詳細は、Ceph Dashboard のシングルサインオンの有効化 を参照してください。

- 監査

ダッシュボードバックエンドは、すべての PUT、POST、および DELETE API 要求を Ceph マネージャーログに記録するように設定できます。

ダッシュボードでマネージャーモジュールを使用する方法の詳細は、ダッシュボードでの Ceph クラスターのマネージャーモジュールの表示および編集 を参照してください。

管理機能

Red Hat Ceph Storage ダッシュボードにはさまざまな管理機能が含まれています。

- クラスター階層の表示

たとえば、CRUSH マップを表示して、特定の OSD ID がどのホストで実行されているかを確認できます。これは、OSD に問題が発生した場合に役立ちます。

詳細は、ダッシュボードでの Ceph クラスターの CRUSH マップ表示 を参照してください。

- マネージャーモジュールの設定

Ceph マネージャーモジュールのパラメーターを表示および変更できます。

詳細は、ダッシュボードでの Ceph クラスターのマネージャーモジュールの表示と編集 を参照してください。

- 埋め込み Grafana ダッシュボード

Ceph Dashboard Grafana ダッシュボードは、パフォーマンスメトリクスを収集する Prometheus モジュールを使用して情報を表示するために、外部アプリケーションや Web ページに埋め込まれる場合があります。

詳細は、Ceph Dashboard コンポーネント を参照してください。

- ログの表示とフィルタリング

イベントおよび監査クラスターログを表示し、優先度、キーワード、日付、または時間範囲に基づいてフィルター処理できます。

詳細は、ダッシュボードでの Ceph クラスターのログのフィルタリング を参照してください。

- ダッシュボードコンポーネントの切り替え

ダッシュボードのコンポーネントを有効および無効にできるため、必要な機能のみが利用可能になります。

詳細は、Ceph Dashboard 機能の切り替え を参照してください。

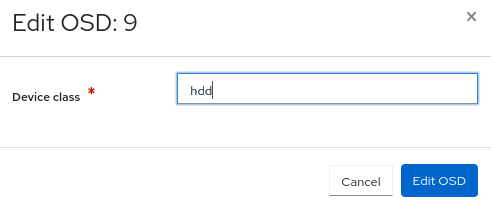

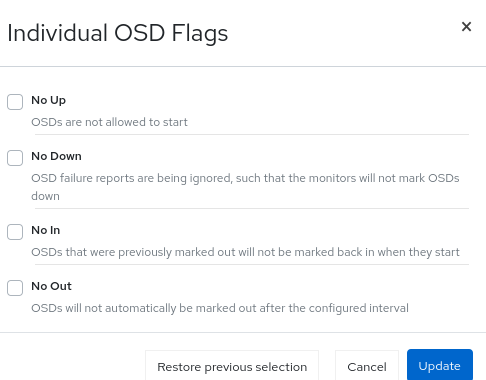

- OSD 設定の管理

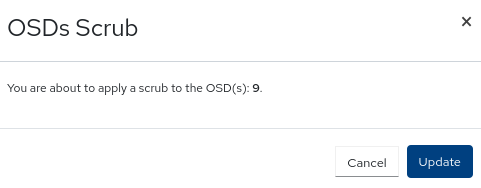

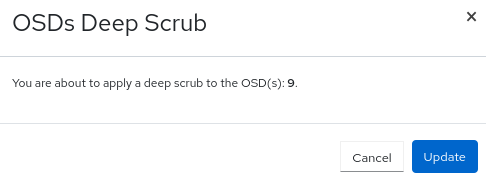

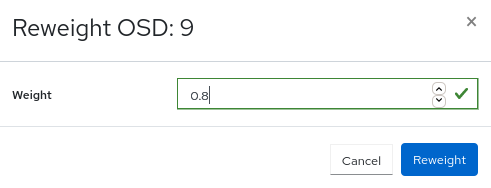

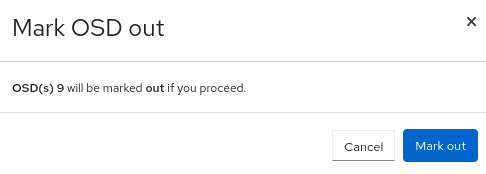

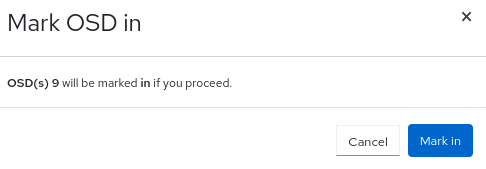

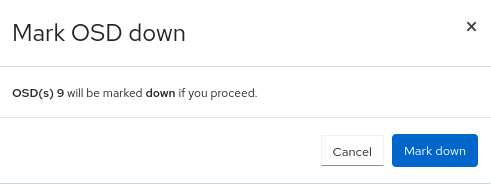

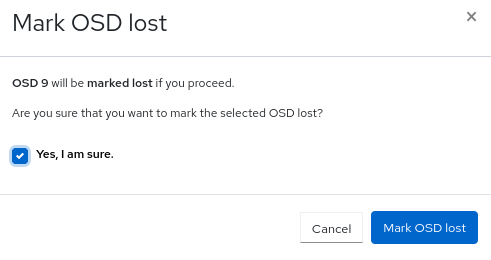

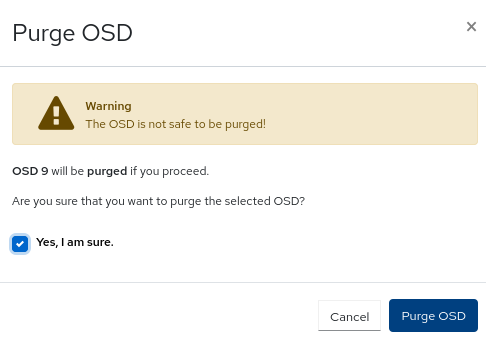

ダッシュボードを使用して、クラスター全体の OSD フラグを設定できます。また、OSD のアップ、ダウン、またはアウトのマーク付け、OSD のパージと加重付け、スクラブ操作の実行、さまざまなスクラブ関連の設定オプションの変更、プロファイルの選択によるバックフィルアクティビティーのレベル調整なども可能です。OSD のデバイスクラスを設定および変更して、デバイスクラス別に OSD を表示して並べ替えることができます。OSD を新しいドライブおよびホストにデプロイできます。

詳細は、ダッシュボードでの Ceph OSD の管理 を参照してください。

- アラートの表示

アラートページでは、現在のアラートの詳細を確認できます。

詳細は、Ceph Dashboard でのアラートの表示 を参照してください。

- アップグレード

ダッシュボードを使用して Ceph クラスターのバージョンをアップグレードできます。

詳細は、クラスターのアップグレード を参照してください。

- イメージのサービス品質

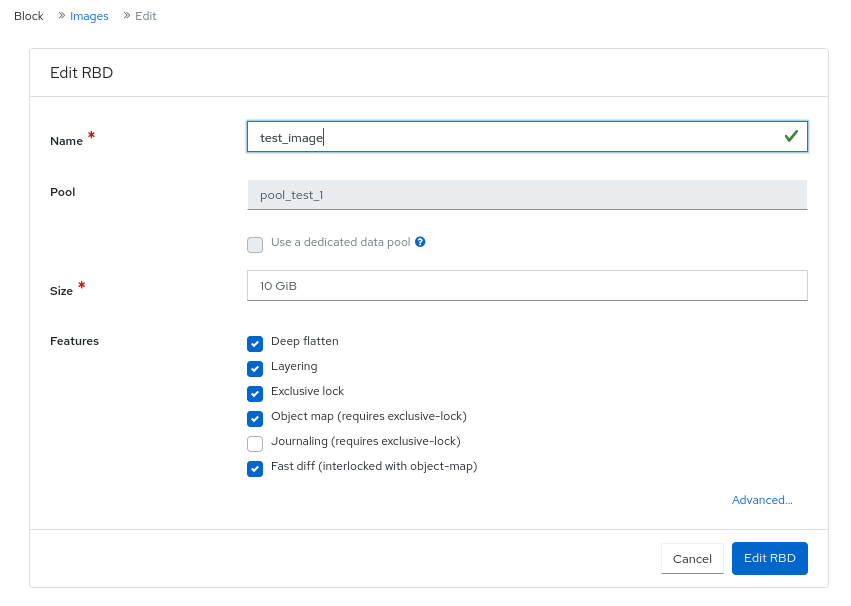

IOPS の制限や、BPS バーストレートの読み取りなど、イメージにパフォーマンス制限を設定できます。

詳細は、Ceph Dashboard でのブロックデバイスイメージの管理 を参照してください。

監視機能

Red Hat Ceph Storage Dashboard からさまざまな機能を監視します。

- ユーザー名とパスワードの保護

ダッシュボードにアクセスするには、設定可能なユーザー名とパスワードを入力する必要があります。

詳細は、Ceph Dashboard でのユーザーの管理 を参照してください。

- クラスター全体の健全性

パフォーマンスと容量のメトリクスを表示します。クラスター全体のステータス、ストレージ使用率 (オブジェクトの数、Raw 容量、プールごとの使用量など)、プールのリストおよびそれらのステータスと使用状況の統計を表示します。

詳細は、ダッシュボードでの Ceph クラスターの設定の表示と編集 を参照してください。

- ホスト

実行中のサービスおよびインストールされた Ceph バージョンと共に、クラスターに関連付けられたホストのリストを提供します。

詳細は、ダッシュボードでの Ceph クラスターのホストの監視 を参照してください。

- パフォーマンスカウンター

実行中の各サービスの詳細な統計情報を表示します。

詳細は、ダッシュボードでの Ceph クラスターのサービスの監視 を参照してください。

- モニター

モニター、クォーラムのステータス、およびオープンセッションのリストを表示します。

詳細は、ダッシュボードでの Ceph クラスターの監視モニター を参照してください。

- 設定エディター

使用可能なすべての設定オプション、その説明、タイプ、デフォルト、および現在設定されている値を表示します。これらの値は編集可能です。

詳細は、ダッシュボードでの Ceph クラスターの設定の表示と編集 を参照してください。

- クラスターログ

クラスターのイベントおよび監査ログファイルの最新の更新を、優先度、日付、またはキーワード別に表示およびフィルタリングします。

詳細は、ダッシュボードでの Ceph クラスターのログのフィルタリング を参照してください。

- デバイス管理

オーケストレーターが認識しているすべてのホストをリスト表示します。ホストに接続されているすべてのドライブとそのプロパティーをリスト表示します。ドライブのヘルス予測、SMART データ、点滅エンクロージャー LED を表示します。

詳細は、ダッシュボードでの Ceph クラスターのホストの監視 を参照してください。

- ストレージクラスターの容量表示

Ceph Dashboard の Capacity ページで、Red Hat Ceph Storage クラスターの生のストレージ容量を表示できます。

詳細は、Ceph Dashboard のランディングページについて を参照してください。

- Pools

すべての Ceph プールとその詳細をリスト表示および管理します。たとえば、アプリケーション、配置グループ、レプリケーションサイズ、EC プロファイル、クォータ、CRUSH ルールセットなどです。

詳細は、Ceph Dashboard のランディングページについて および ダッシュボードでの Ceph クラスターのプールの監視 を参照してください。

- OSD

すべての OSD、そのステータス、および使用状況統計をリスト表示して管理します。OSD には、属性、OSD マップ、メタデータ、読み取りおよび書き込み操作のパフォーマンスカウンターなどの詳細情報もリスト表示されます。OSD には、OSD に関連付けられているすべてのドライブもリスト表示されます。

詳細は、ダッシュボードでの Ceph OSD の監視 を参照してください。

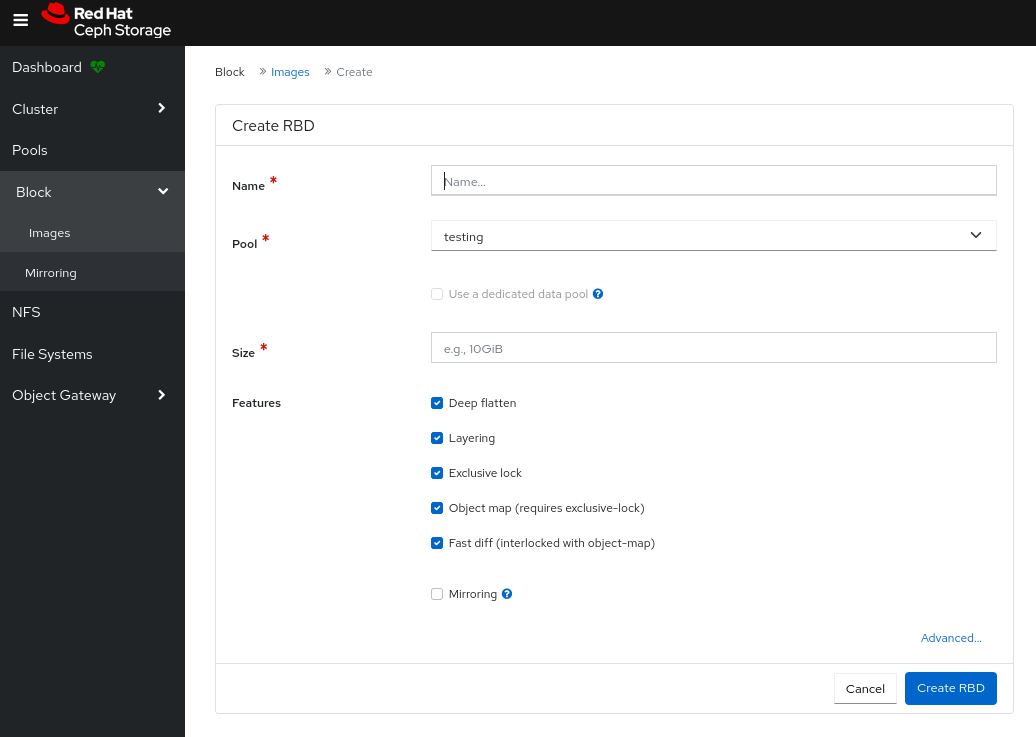

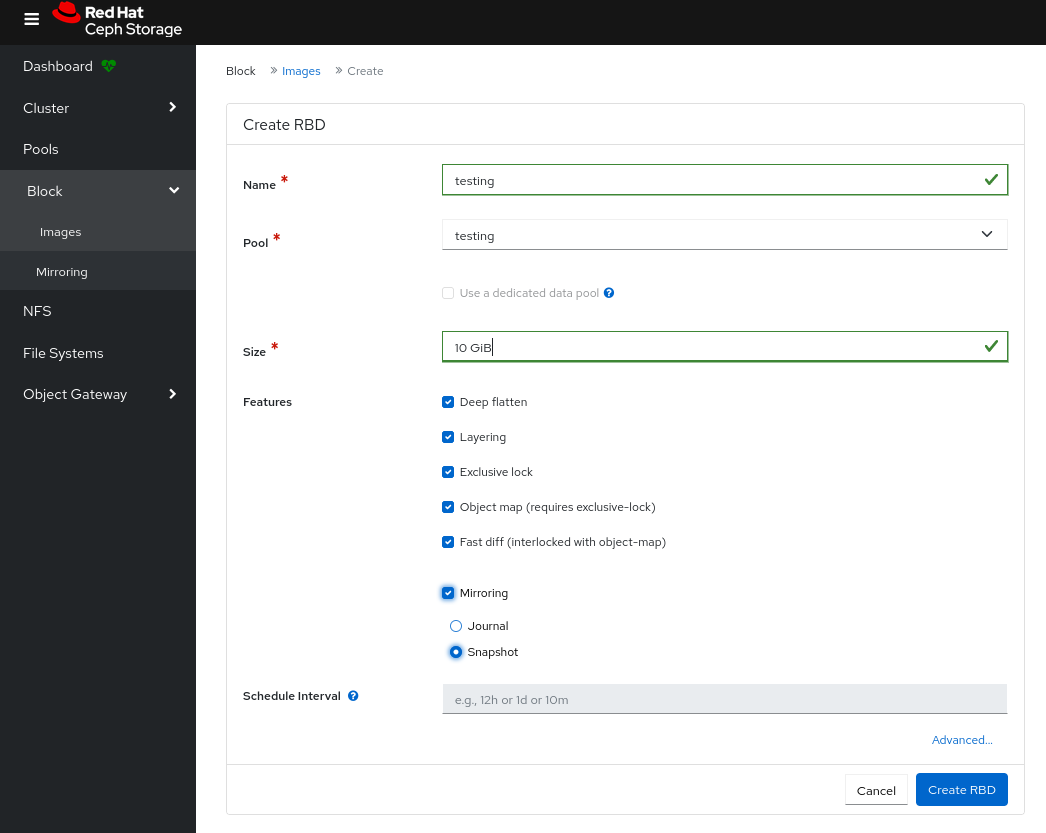

- イメージ

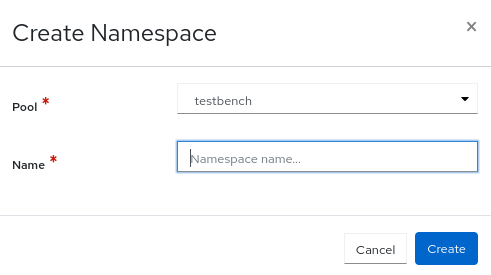

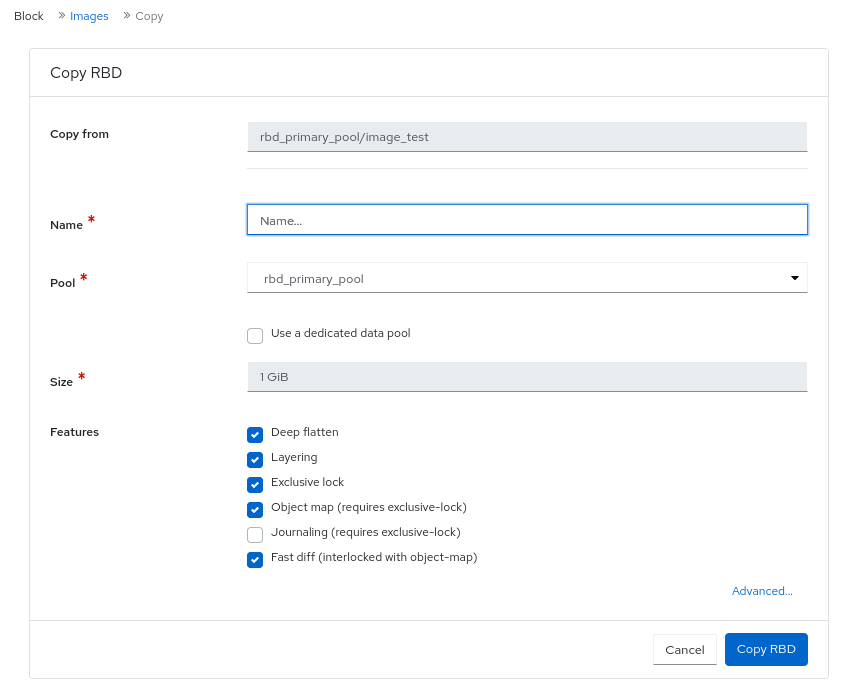

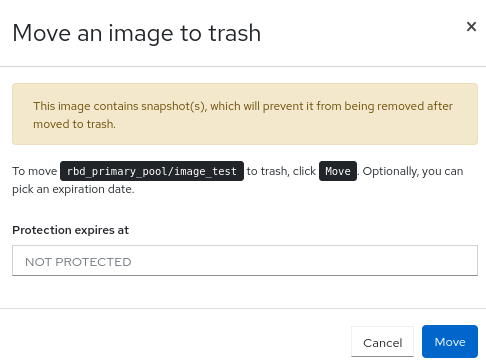

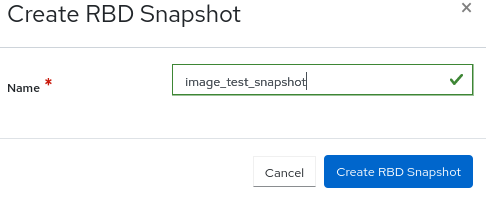

すべての Ceph ブロックデバイス (RBD) イメージと、サイズ、オブジェクト、機能などのプロパティーをリスト表示します。RBD イメージの作成、コピー、変更、および削除を行います。選択したイメージのスナップショットを作成、削除、およびロールバックし、変更に対してこのスナップショットを保護するか、保護を解除します。スナップショットをコピーまたはクローンし、クローンしたイメージをフラット化します。

注記特定のイメージの Overall Performance タブの I/O 変更のパフォーマンスグラフには、Cluster→Manager modules→Prometheus の

rbd_stats_poolパラメーターを設定すると、そのイメージを含むプールを指定した後にのみ値が表示されます。詳細は、Ceph Dashboard でのブロックデバイスイメージの監視 を参照してください。

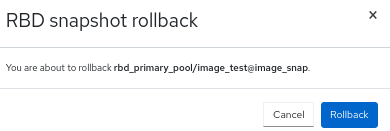

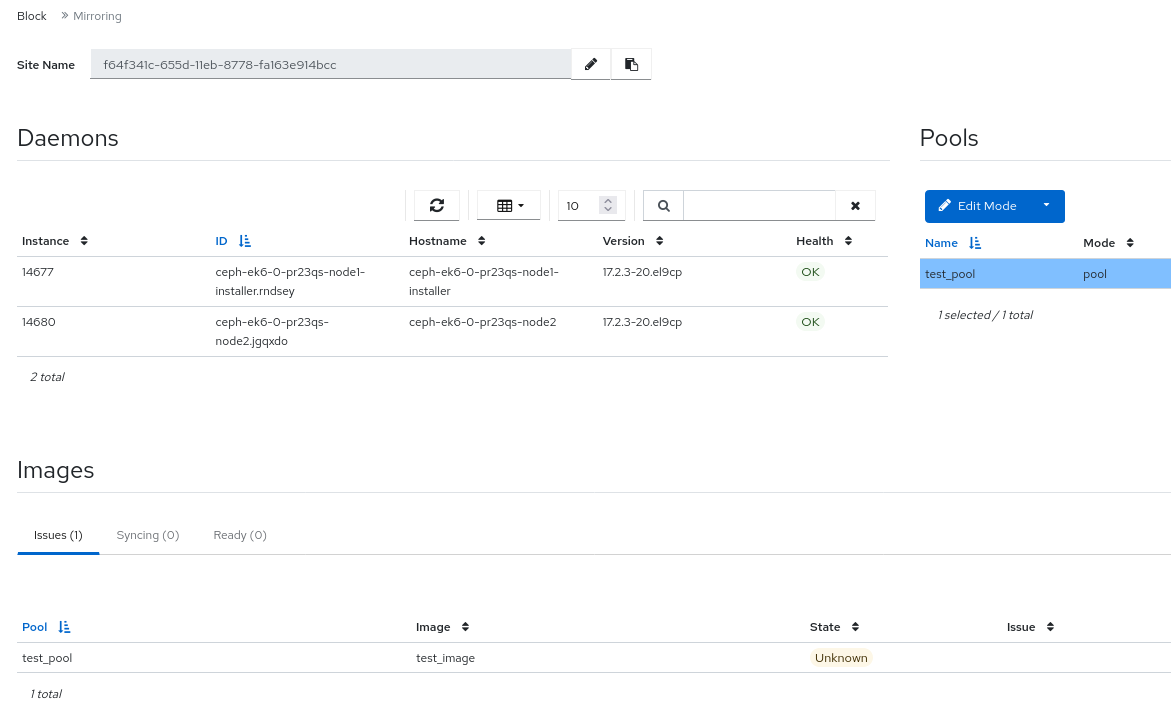

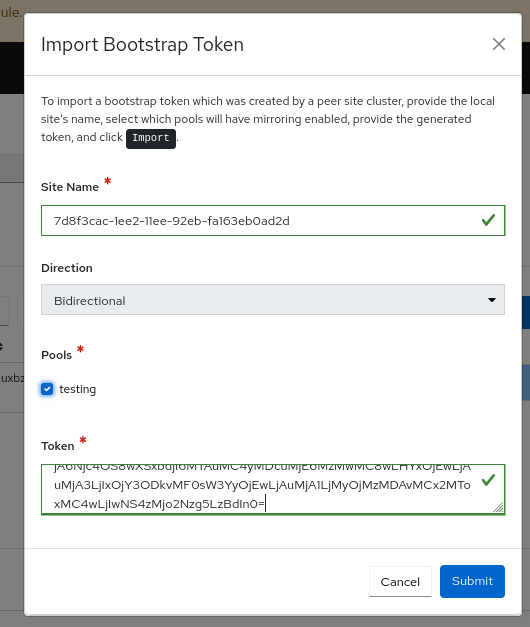

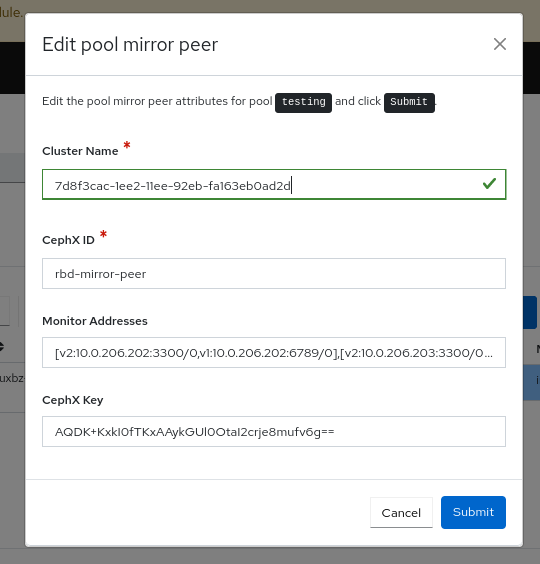

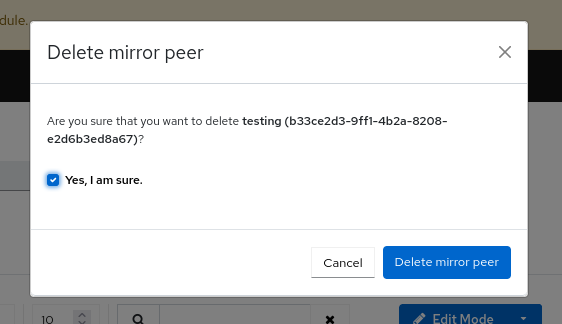

- ブロックデバイスのミラーリング

リモート Ceph サーバーへの Ceph ブロックデバイス (RBD) ミラーリングを有効にして設定します。同期状態を含む、すべてのアクティブな同期デーモンとそのステータス、プール、および RBD イメージのリストを表示します。

詳細は、Ceph Dashboard のミラーリングビュー を参照してください。

- Ceph ファイルシステム

アクティブな Ceph ファイルシステム (CephFS) クライアントと関連するプール (使用状況の統計を含む) のリストを表示します。アクティブな CephFS クライアントを退避し、CephFS クォータとスナップショットを管理して、CephFS ディレクトリー構造を参照します。

詳細は、ダッシュボードでの Ceph ファイルシステムの監視 を参照してください。

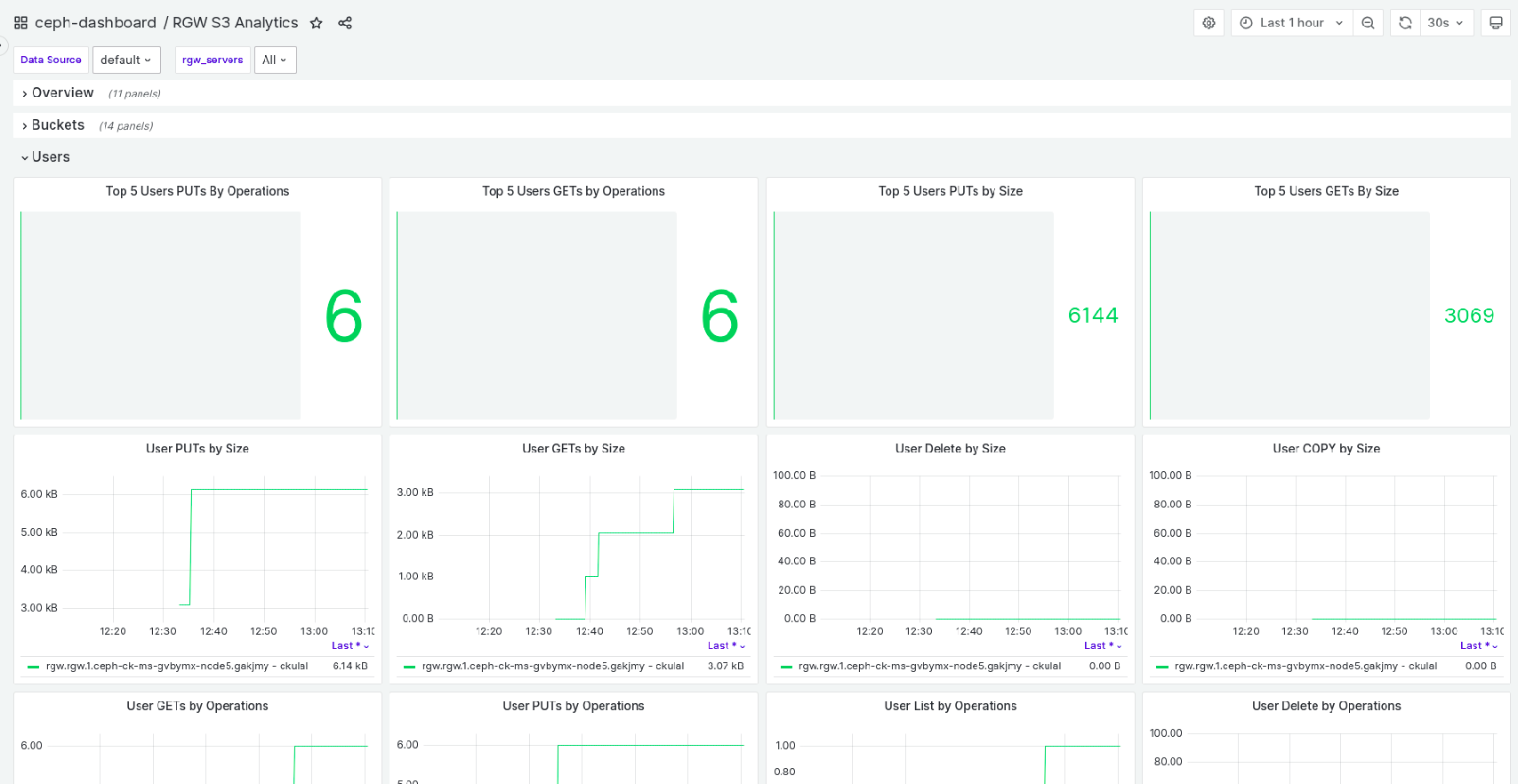

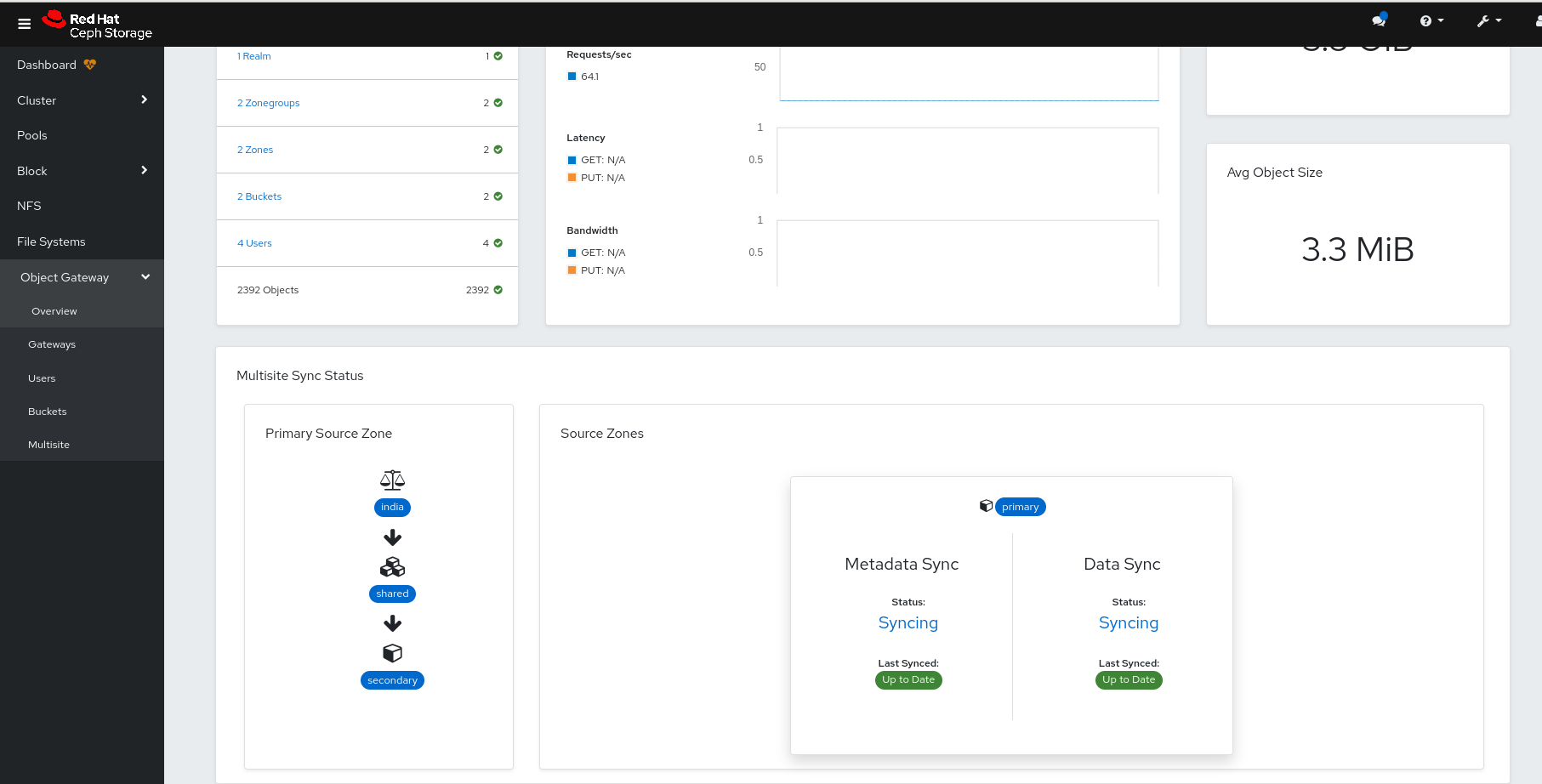

- Object Gateway (RGW)

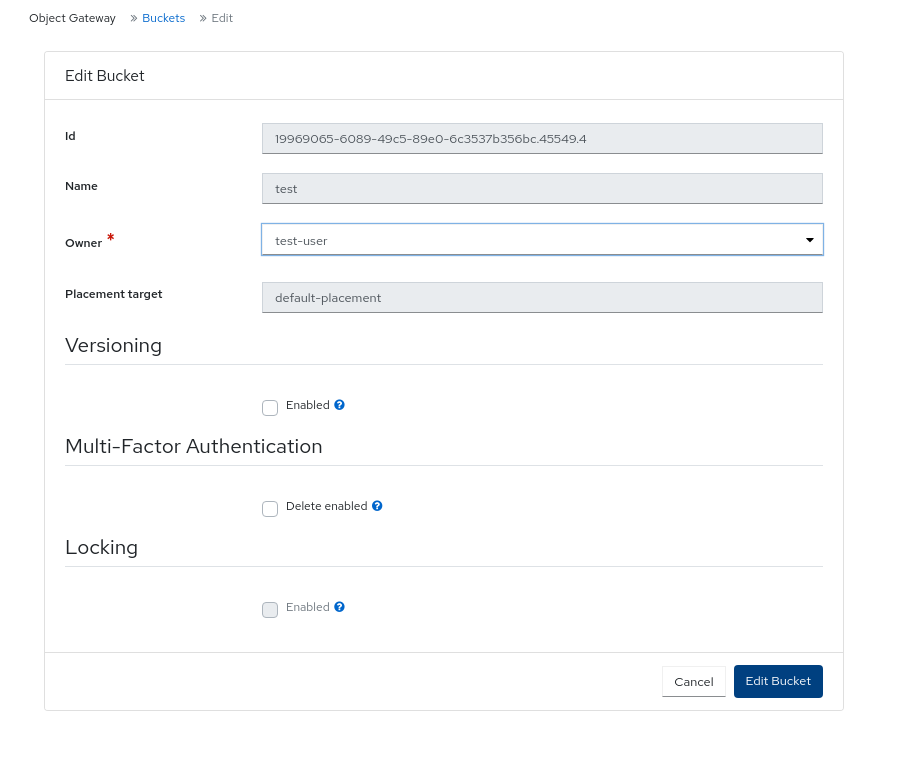

すべてのアクティブなオブジェクトゲートウェイとそのパフォーマンスカウンターをリスト表示します。Ceph Object Gateway ユーザーとその詳細 (クォータなど)、およびユーザーのバケットとその詳細 (所有者やクォータなど) を表示および管理 (追加、編集、削除など) します。

詳細は、ダッシュボードでの Ceph Object Gateway デーモンの監視 を参照してください。

セキュリティー機能

ダッシュボードには次のセキュリティー機能が提供されます。

- SSL および TLS サポート

Web ブラウザーとダッシュボード間の HTTP 通信はすべて SSL 経由で保護されます。自己署名証明書は組み込みコマンドで作成できますが、認証局 (CA) が署名して発行したカスタム証明書をインポートすることもできます。

詳細は、Ceph Dashboard のインストールおよびアクセス を参照してください。

前提条件

- システム管理者レベルの経験

1.1. Ceph Dashboard コンポーネント

ダッシュボードの機能は複数のコンポーネントで提供されます。

- デプロイメント用の Cephadm アプリケーション。

-

埋め込みダッシュボードである

ceph-mgrモジュール。 -

埋め込み Prometheus である

ceph-mgrモジュール。 - Prometheus の時系列データベース。

- ストレージクラスターの各ホストで実行される Prometheus の node-exporter デーモン。

- 監視ユーザーインターフェイスおよびアラートを提供する Grafana プラットフォーム。

- ノードプロキシーエージェントは、iLO などの帯域外 (OOB) インターフェイスからハードウェアのヘルスデータを収集する、すべてのノード上のバックグラウンドサービスです。IBM Storage Ceph Ceph 7.1 ではハードウェア監視機能がデフォルトで有効になっているため、ユーザーは手動で設定しなくてもダッシュボードまたはログで関連データを表示できます。

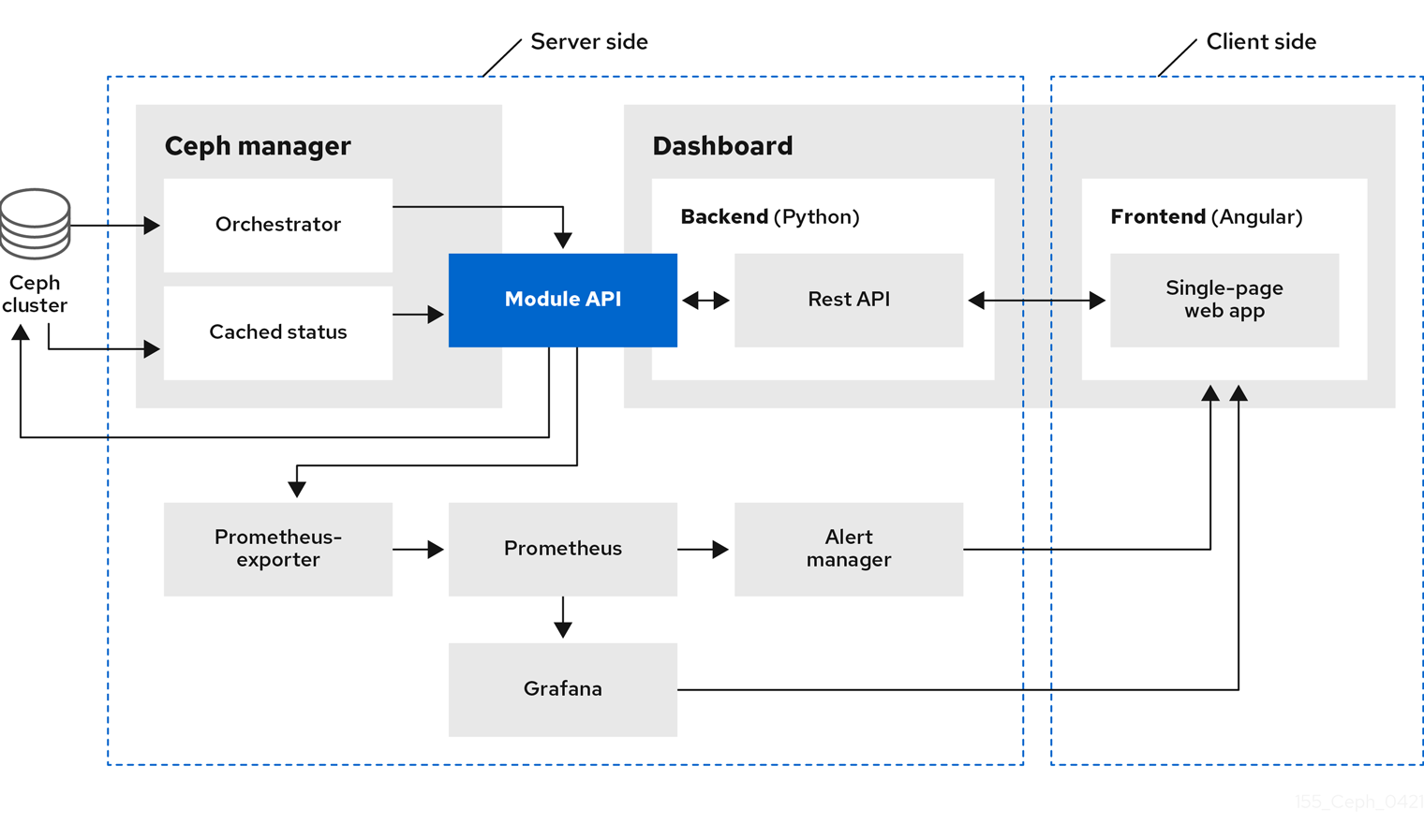

1.2. Red Hat Ceph ストレージダッシュボードアーキテクチャー

Dashboard アーキテクチャーは、Ceph Manager のダッシュボードプラグインおよびその他のコンポーネントによって異なります。Ceph マネージャーとダッシュボードがどのように連携するかを理解するには、次の図を参照してください。

第2章 Ceph Dashboard のインストールおよびアクセス

システム管理者は、クラスターのブートストラップ時に提示された認証情報を使用してダッシュボードにアクセスできます。

Cephadm はデフォルトでダッシュボードをインストールします。以下は、ダッシュボード URL の例です。

URL: https://host01:8443/ User: admin Password: zbiql951ar

URL: https://host01:8443/

User: admin

Password: zbiql951arダッシュボード URL にアクセスする前に、ブラウザーを更新して Cookie をクリアします。

Ceph Dashboard 設定で使用できる Cephadm ブートストラップオプションを以下に示します。

- [—initial-dashboard-user INITIAL_DASHBOARD_USER] - 初期ダッシュボードユーザーを設定するには、ブートストラップ中にこのオプションを使用します。

- [—initial-dashboard-password] - 初期ダッシュボードパスワードを設定するには、ブートストラップ中にこのオプションを使用します。

- [-SSL-dashboard-port SSL_DASHBOARD_PORT] - このオプションを使用して、ブートストラップ時にデフォルトの 8443 以外のカスタムダッシュボードポートを設定します。

- [—dashboard-key DASHBOARD_KEY] - SSL のカスタムキーを設定するには、ブートストラップ中にこのオプションを使用します。

- [—dashboard-crt DASHBOARD_CRT] - SSL のカスタム証明書を設定するには、ブートストラップ中にこのオプションを使用します。

- [—skip-dashboard] - ダッシュボードなしで Ceph をデプロイするには、ブートストラップ中にこのオプションを使用します。

- [—dashboard-password-noupdate] - 上記の 2 つのオプションを使用して初回ログイン時にパスワードをリセットしない場合は、ブートストラップ中にこのオプションを使用します。

- [–allow-fqdn-hostname] - 完全修飾ホスト名を使用できるようにするには、ブートストラップ中にこのオプションを使用します。

- [—skip-prepare-host] - ホストの準備をスキップするには、ブートストラップ中にこのオプションを使用します。

ダッシュボード関連の外部 URL の接続の問題を回避するには、ホスト名に完全修飾ドメイン名 (FQDN) を使用します (例:host01.ceph.redhat.com)。

クライアントのインターネットブラウザーで Grafana URL を直接開き、セキュリティー例外を受け入れ、Ceph Dashboard のグラフを確認します。ブラウザーをリロードして、変更を表示します。

例

cephadm bootstrap --mon-ip 127.0.0.1 --registry-json cephadm.txt --initial-dashboard-user admin --initial-dashboard-password zbiql951ar --dashboard-password-noupdate --allow-fqdn-hostname

[root@host01 ~]# cephadm bootstrap --mon-ip 127.0.0.1 --registry-json cephadm.txt --initial-dashboard-user admin --initial-dashboard-password zbiql951ar --dashboard-password-noupdate --allow-fqdn-hostname

cephadm を使用してストレージクラスターをブートストラップするときに、カスタムコンテナーイメージまたはローカルコンテナーイメージに —image オプションを使用できます。

ブートストラップ時に —dashboard-password-noupdate オプションを使用しない場合にのみ、ブートストラップ時に指定した認証情報を使用してダッシュボードへの初回ログイン時にパスワードを変更する必要があります。Ceph Dashboard の認証情報は var/log/ceph/cephadm.log ファイルにあります。"Ceph Dashboard is now available at" という文字列で検索します。

このセクションでは、次のタスクを説明します。

- Ceph Dashboard のネットワークポート要件

- Ceph Dashboard へのアクセス

- Ceph Dashboard でのクラスターのデプロイメント

- クラスターのアップグレード

- Ceph Dashboard 機能の切り替え

- Ceph Dashboard のランディングページの理解

- Red Hat Ceph Storage Dashboard の手動での有効化

- Ceph Dashboard を使用したダッシュボードパスワードの変更

- コマンドラインインターフェイスを使用した Ceph Dashboard のパスワードの変更

-

Grafana の

adminユーザーパスワードの設定 - Ceph Dashboard にユーザーを同期するための管理者アカウントの作成

- Red Hat シングルサインオンを使用した Ceph Dashboard とユーザーの同期

- Ceph Dashboard のシングルサインオンの有効化

- Ceph Dashboard のシングルサインオンの無効化

2.1. Ceph Dashboard のネットワークポート要件

Ceph Dashboard のコンポーネントは、アクセス可能である必要のある、特定の TCP ネットワークポートを使用します。デフォルトでは、Red Hat Ceph Storage のインストール時に、ネットワークポートは firewalld で自動的に開きます。

| ポート | 使用方法 | 発信元ホスト | 宛先ホスト |

|---|---|---|---|

| 8443 | ダッシュボードの Web インターフェイス | AlertManager サービスはアラートを報告するために Dashboard への接続も開始できるため、Ceph Dashboard UI および Grafana サーバー配下のホストにアクセスする必要がある IP アドレス。 | Ceph Manager ホスト。 |

| 3000 | Grafana | Grafana Dashboard UI およびすべての Ceph Manager ホストと Grafana サーバーへのアクセスが必要な IP アドレス。 | Grafana サーバーを実行しているホスト (1 つまたは複数)。 |

| 2049 | NFS-Ganesha | NFS にアクセスする必要がある IP アドレス。 | NFS サービスを提供する IP アドレス。 |

| 9095 | 基本的な Prometheus グラフ用のデフォルトの Prometheus サーバー | Prometheus UI およびすべての Ceph Manager ホストと Grafana サーバーまたは Prometheus を実行しているホストへのアクセスが必要な IP アドレス。 | Prometheus を実行しているホスト。 |

| 9093 | Prometheus Alertmanager | Alertmanager Web UI およびすべての Ceph Manager ホストと Grafana サーバーまたは Prometheus を実行しているホストへのアクセスが必要な IP アドレス。 | すべての Ceph Manager ホストと Grafana サーバー配下のホスト。 |

| 9094 | 複数のインスタンスから作成された可用性の高いクラスターを設定するための Prometheus Alertmanager | すべての Ceph Manager ホストと Grafana サーバー配下のホスト。 |

Prometheus Alertmanager の高可用性 (ピアデーモン同期)。したがって、 |

| 9100 |

Prometheus の | Node Exporter メトリック Web UI を表示する必要がある Prometheus を実行しているホスト、およびすべての Ceph Manager ホストと Grafana サーバー、または Prometheus を実行しているホスト。 | MON、OSDS、Grafana サーバーホストを含む、すべてのストレージクラスターホスト。 |

| 9283 | Ceph Manager Prometheus エクスポーターモジュール | Ceph Exporter メトリック Web UI および Grafana サーバーにアクセスする必要がある Prometheus を実行しているホスト。 | すべての Ceph Manager ホスト。 |

2.2. Ceph Dashboard へのアクセス

Ceph Dashboard にアクセスして Red Hat Ceph Storage クラスターを管理および監視できます。

前提条件

- Red Hat Ceph Storage Dashboard の正常なインストール

- NTP はクロックを適切に同期しています。

手順

Web ブラウザーで、以下の URL を入力します。

構文

https://HOST_NAME:PORT

https://HOST_NAME:PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下を置き換えます。

- HOST_NAME は、アクティブなマネージャーホストの完全修飾ドメイン名 (FQDN) に置き換えます。

PORT は、ポート

8443に置き換えます。例

https://host01:8443

https://host01:8443Copy to Clipboard Copied! Toggle word wrap Toggle overflow Cephadm シェルで次のコマンドを実行して、ダッシュボードの URL を取得することもできます。

例

[ceph: root@host01 /]# ceph mgr services

[ceph: root@host01 /]# ceph mgr servicesCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドは、現在設定されているすべてのエンドポイントを表示します。

ダッシュボードキーを探して、ダッシュボードにアクセスするための URL を取得します。

-

ログインページで、ブートストラップ時に指定したユーザー名

adminとデフォルトパスワードを入力します。 - Red Hat Ceph Storage ダッシュボードに初めてログインするときにパスワードを変更する必要があります。

ログイン後、ダッシュボードのデフォルトのランディングページが表示され、Red Hat Ceph Storage クラスターのステータス、パフォーマンス、インベントリー、および容量メトリックの詳細と高レベルの概要が表示されます。

図2.1 Ceph Dashboard のランディングページ

-

ダッシュボードランディングページのメニューアイコン (

) をクリックして、垂直メニューのオプションを折りたたむか表示します。

) をクリックして、垂直メニューのオプションを折りたたむか表示します。

2.3. Ceph Dashboard でのクラスターのデプロイメント

ダッシュボードを使用して、Red Hat Ceph Storage クラスターを拡張し、ホストの追加、OSD の追加、Alertmanager、Cephadm-exporter、CephFS-mirror、Grafana、ingress、MDS、NFS、node-exporter、Prometheus、BD ミラー、Ceph Object Gateway などのサービスの作成を行うことができます。

新しいストレージクラスターをブートストラップすると、Ceph Monitor Daemon と Ceph Manager Daemon が作成され、クラスターは HEALTH_WARN 状態になります。ダッシュボードでクラスターのすべてのサービスを作成すると、クラスターの正常性が HEALTH_WARN から HEALTH_OK ステータスに変わります。

前提条件

- ブートストラップされたストレージクラスター。詳細は、Red Hat Ceph Storage インストールガイド の 新しいストレージクラスターのブートストラップ セクションを参照してください。

-

Red Hat Ceph ストレージダッシュボード上のユーザーの少なくとも

cluster-managerロール。詳細は、Red Hat Ceph Storage ダッシュボードガイド の Ceph ダッシュボードのユーザーロールと権限 セクションを参照してください。

手順

ブートストラップされたホストから他のホストに管理キーをコピーします。

構文

ssh-copy-id -f -i /etc/ceph/ceph.pub root@HOST_NAME

ssh-copy-id -f -i /etc/ceph/ceph.pub root@HOST_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ssh-copy-id -f -i /etc/ceph/ceph.pub root@host02 [ceph: root@host01 /]# ssh-copy-id -f -i /etc/ceph/ceph.pub root@host03

[ceph: root@host01 /]# ssh-copy-id -f -i /etc/ceph/ceph.pub root@host02 [ceph: root@host01 /]# ssh-copy-id -f -i /etc/ceph/ceph.pub root@host03Copy to Clipboard Copied! Toggle word wrap Toggle overflow - ブートストラップ中に提供されたデフォルトの認証情報を使用してダッシュボードにログインします。

- パスワードを変更し、新しいパスワードでダッシュボードにログインします。

ランディングページで、Expand Cluster をクリックします。

注記Expand Cluster をクリックすると、デプロイ手順を案内するウィザードが開きます。スキップしてホストとサービスを個別に追加するには、Skip をクリックします。

図2.2 クラスターのデプロイメント

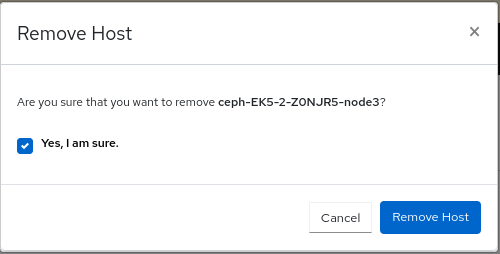

ホストを追加します。これは、ストレージクラスター内の各ホストに対して実行する必要があります。

- Add Hosts の手順で、Add をクリックします。

ホスト名を指定します。これは、ブートストラップされたホストからキーをコピーするときに提供されたホスト名と同じです。

注記ホスト名のコンマ区切りリスト、範囲式、またはコンマ区切りの範囲式を使用して、複数のホストを追加します。

- オプション: ホストのそれぞれの IP アドレスを指定します。

- オプション: サービスが作成されるホストのラベルを選択します。新しいラベルを選択または追加するには、鉛筆アイコンをクリックします。

Add Host をクリックします。

Add Hosts ペインに新しいホストが表示されます。

- Next をクリックします。

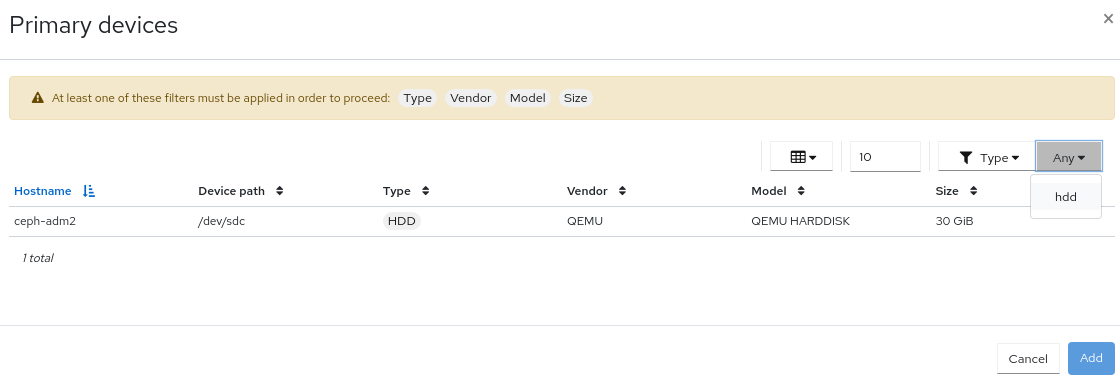

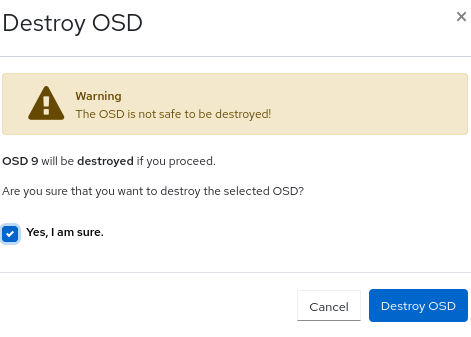

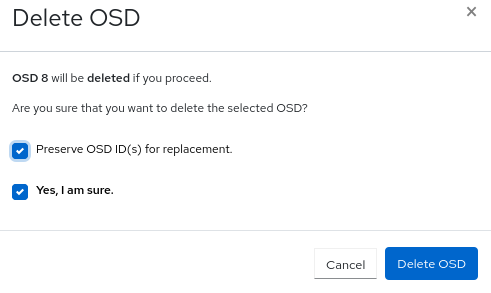

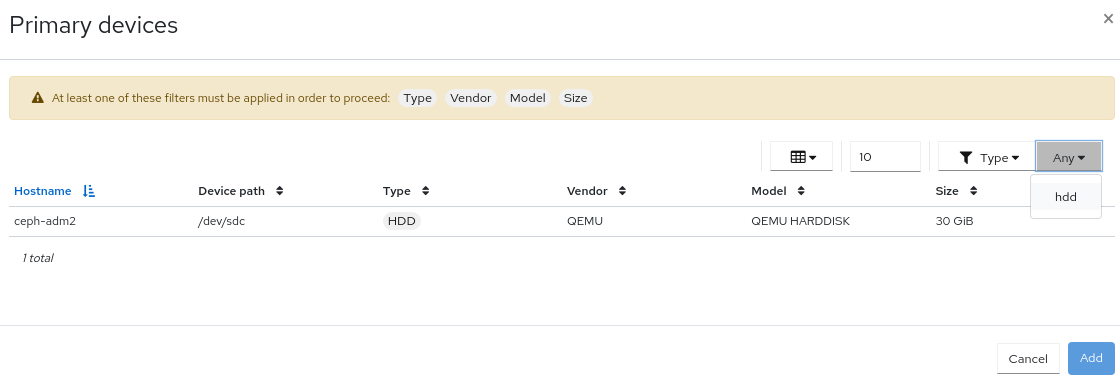

OSD を作成します。

- Create OSDs の手順で、プライマリーデバイスの Add をクリックします。

- Primary Devices ウィンドウで、デバイスをフィルタリングして選択します。

- Add をクリックします。

- オプション: Create OSDs ウィンドウで、WAL や DB デバイスなどの共有デバイスがある場合はデバイスを追加します。

- オプション: Features セクションで、Encryption を選択して機能を暗号化します。

- Next をクリックします。

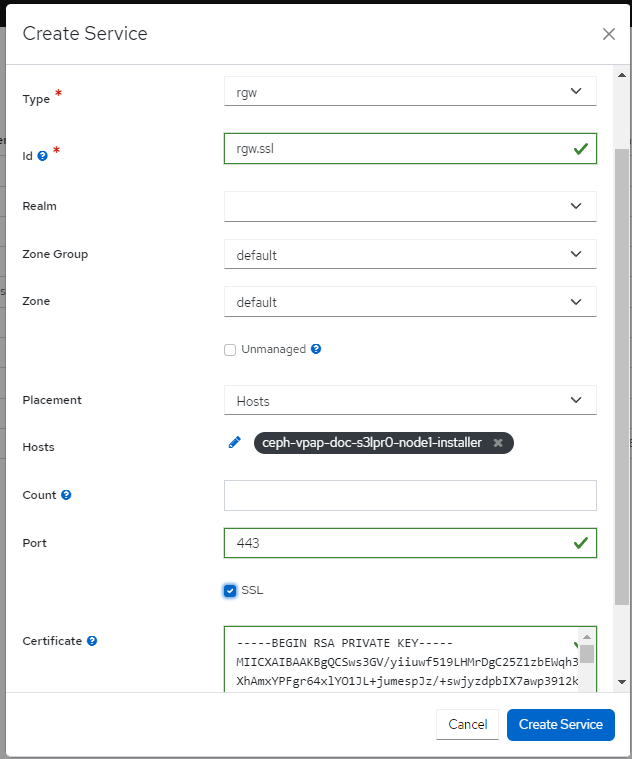

サービスを作成します。

- Create Services の手順で、Create をクリックします。

Create Service フォームで、以下を実行します。

- サービスタイプを選択します。

-

サービス ID を指定します。ID はサービスの一意の名前です。この ID は、サービス名 (

service_type.service_id) で使用されます。

…オプション: サービスが Unmanaged の場合は選択します。

+ Unmanaged サービスを選択すると、オーケストレーターはこのサービスに関連付けられているデーモンを起動または停止しません。配置およびその他のすべてのプロパティーは無視されます。

- ホスト別の配置かラベル別の配置かを選択します。

- ホストを選択します。

Count フィールドに、デプロイする必要があるデーモンまたはサービスの数を入力します。

Create Service をクリックします。

Create Services ペインに新しいサービスが表示されます。

- Create Service ウィンドウで、Next をクリックします。

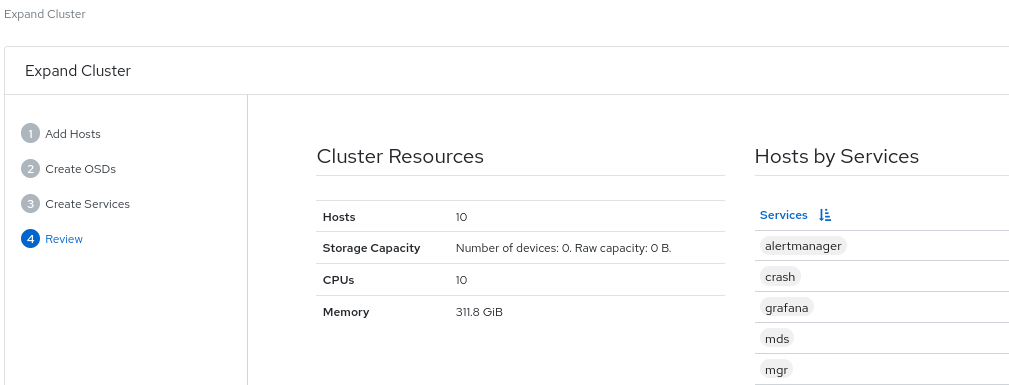

クラスターのデプロイメントの詳細を確認します。

Cluster Resources、Hosts by Services、Host Details を確認します。パラメーターを編集するには、Back をクリックして前の手順に従います。

図2.3 クラスターのレビュー

Expand Cluster をクリックします。

Cluster expansion displayed通知が表示され、ダッシュボード上でクラスターのステータスが HEALTH_OK に変わります。

検証

cephadmシェルにログインします。例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow ceph-sコマンドを実行します。例

[ceph: root@host01 /]# ceph -s

[ceph: root@host01 /]# ceph -sCopy to Clipboard Copied! Toggle word wrap Toggle overflow クラスターの正常性は HEALTH_OK です。

2.4. クラスターのアップグレード

ダッシュボードを使用して Ceph クラスターをアップグレードします。

クラスターイメージは registry.redhat.io から自動的にプルされます。必要に応じて、アップグレードにカスタムイメージを使用します。

手順

ダッシュボードの Administration > Upgrade から、クラスターのアップグレードが利用可能かどうかを確認し、必要に応じてアップグレードします。

注記ダッシュボードに

Not retrieving upgradesというメッセージが表示された場合は、レジストリーが Podman または Docker への適切なログイン認証情報を使用してコンテナー設定ファイルに追加されたかどうかを確認してください。必要に応じて、アップグレードプロセス中に Pause または Stop をクリックします。アップグレードの進捗は、アップグレード中の情報メッセージとともに進捗バーに表示されます。

注記アップグレードを停止する場合、まずアップグレードが一時停止し、その後アップグレードの停止を求めるプロンプトが表示されます。

- オプション: Upgrade ページの Cluster logs セクションから、アップグレードプロセス中のクラスターログを表示します。

- クラスターのステータスに OK 状態が表示されていることを確認して、アップグレードが正常に完了したことを確認します。

2.5. Ceph Dashboard 機能の切り替え

オンデマンドで機能を有効または無効にすることで、Red Hat Ceph Storage ダッシュボードのコンポーネントをカスタマイズできます。デフォルトでは、すべての機能が有効になっています。機能を無効にすると、Web インターフェイス要素は非表示になり、関連付けられた REST API のエンドポイントはその機能に対する追加のリクエストを拒否します。ダッシュボード機能の有効化および無効化は、コマンドラインインターフェイスまたは Web インターフェイスから実行できます。

利用可能な機能:

Ceph ブロックデバイス:

-

イメージの管理 (

rbd) -

ミラーリング (

mirroring)

-

イメージの管理 (

-

Ceph File System (

cephfs) -

Ceph Object Gateway (

rgw) -

NFS Ganesha ゲートウェイ (

nfs)

デフォルトでは、Ceph Manager は Ceph Monitor と併置されます。

複数の機能を一度に無効にできます。

機能が無効になったら、Web インターフェイスの変更を反映するのに最大 20 秒かかる場合があります。

前提条件

- Red Hat Ceph Storage ダッシュボードソフトウェアのインストールおよび設定

- Ceph Manager ホストまたはダッシュボードの Web インターフェイスへのユーザーアクセス

- Ceph Manager ホストへの root レベルのアクセス

手順

ダッシュボードの Web インターフェイスからダッシュボード機能を切り替えるには、以下を実行します。

- ダッシュボードのランディングページで、Administration→Manager Modules に移動し、ダッシュボードモジュールを選択します。

- Edit をクリックします。

- Edit Manager module フォームでは、機能名の横にあるチェックボックスを選択または選択解除することで、ダッシュボード機能を有効または無効にできます。

- 選択が完了したら、Update をクリックします。

コマンドラインインターフェイスからダッシュボード機能を切り替えるには、以下を実行します。

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow 機能のステータスのリストを表示します。

例

[ceph: root@host01 /]# ceph dashboard feature status

[ceph: root@host01 /]# ceph dashboard feature statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow 機能を無効にします。

[ceph: root@host01 /]# ceph dashboard feature disable rgw

[ceph: root@host01 /]# ceph dashboard feature disable rgwCopy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、Ceph Object Gateway 機能を無効にします。

機能を有効にします。

[ceph: root@host01 /]# ceph dashboard feature enable cephfs

[ceph: root@host01 /]# ceph dashboard feature enable cephfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例では、Ceph Filesystem 機能を有効にします。

2.6. Ceph Dashboard のランディングページの理解

ランディングページには、ナビゲーションバーと個別のパネルを使用した Ceph クラスター全体の概要が表示されます。

メニューバーには次のオプションがあります。

- Tasks and Notifications

- タスクと通知メッセージが表示されます。

- Help

- 製品および REST API のドキュメントリンク、Red Hat Ceph Storage ダッシュボードの詳細、および問題を報告するためのフォームが表示されます。

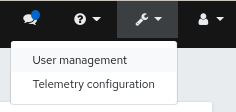

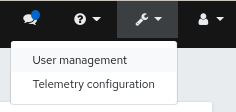

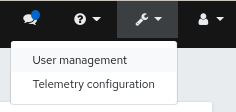

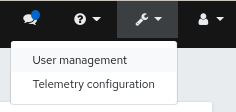

- Dashboard Settings

- ユーザー管理とテレメトリー設定にアクセスできます。

- User

- このメニューを使用して、ログインステータスの確認、パスワードの変更、ダッシュボードからのサインアウトを行えます。

図2.4 メニューバー

ナビゲーションメニューを開く、または非表示にするには、ナビゲーションメニューアイコン

をクリックします。

をクリックします。

Dashboard

メインダッシュボードには、クラスターの状態に関する具体的な情報が表示されます。

ナビゲーションメニューから Dashboard をクリックすることで、いつでもメインダッシュボードにアクセスできます。

ダッシュボードのランディングページでは、ペインがさまざまなカテゴリーに整理されています。

図2.5 Ceph Dashboard のランディングページ

- Details

- 特定のクラスター情報と、テレメトリーがアクティブか非アクティブかが表示されます。

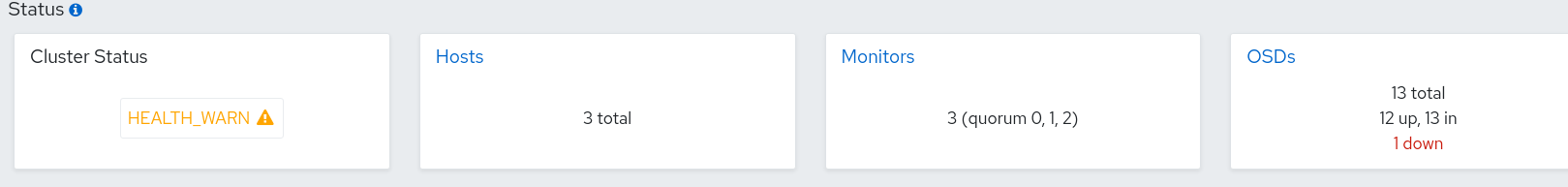

- Status

- クラスターの健全性と、ホストおよびデーモンの状態が表示されます。Ceph Storage クラスターの現在のヘルスステータスが表示されます。危険アラートおよび警告アラートは、ランディングページに直接表示されます。アラートの完全なリストを表示するには、View alerts をクリックします。

- Capacity

- ストレージ使用状況のメトリクスが表示されます。これは、使用状況、警告、危険のグラフとして表示されます。数字はパーセンテージと GiB で表されます。

- Inventory

クラスターのさまざまな部分、使用可能な数、それらのステータスが表示されます。

使用可能な場合は、Inventory から特定のインベントリー項目に直接リンクされます。

- Hosts

- Ceph Storage クラスターのホストの合計数が表示されます。

- Monitors

- Ceph Monitor の数およびクォーラムのステータスが表示されます。

- Managers

- Manager Daemon の数およびステータスが表示されます。

- OSD

- Ceph Storage クラスター内の OSD の合計数と、up および in の数が表示されます。

- Pools

- Ceph クラスター内のストレージプールの数が表示されます。

- PGs

配置グループ (PG) の合計数が表示されます。PG の状態は、表示をシンプルにするために Working と Warning に分けられています。それぞれに複数の状態が含まれます。それに加え、Working 状態には次のいずれかの状態の PG が含まれます。

- activating

- backfill_wait

- backfilling

- creating

- deep

- degraded

- forced_backfill

- forced_recovery

- peering

- peered

- recovering

- recovery_wait

- repair

- scrubbing

- snaptrim

- snaptrim_wait + Warning 状態には、次のいずれかの状態の PG が含まれます。

- backfill_toofull

- backfill_unfound

- down

- incomplete

- inconsistent

- recovery_toofull

- recovery_unfound

- remapped

- snaptrim_error

- stale

- undersized

- Object Gateways

- Ceph Storage クラスター内のオブジェクトゲートウェイの数が表示されます。

- Metadata Servers

- Ceph File Systems (CephFS) のメタデータサーバーの数とステータスが表示されます。

- Cluster Utilization

- Cluster Utilization ペインには、データ転送速度に関連する情報が表示されます。リストから、データ出力の時間範囲を選択します。過去 5 分間から過去 24 時間までの範囲を選択します。

- Used Capacity (RAW)

- 使用量が GiB 単位で表示されます。

- IOPS

- 1 秒あたりの I/O 読み取り操作および書き込み操作の合計が表示されます。

- OSD Latencies

- ミリ秒あたりの適用とコミットの合計が表示されます。

- Client Throughput

- クライアントの読み取りおよび書き込みスループットの合計が KiB/秒単位で表示されます。

- Recovery Throughput

- クラスターの修復およびバランス調整操作の速度が表示されます。たとえば、ディスクの損失により移動している可能性のあるバックグラウンドデータのステータスが表示されます。情報は、1 秒あたりのバイト数で表示されます。

2.7. Ceph Dashboard を使用したダッシュボードパスワードの変更

デフォルトでは、ダッシュボードにアクセスするためのパスワードは、クラスターのブートストラップ中にシステムでランダムに生成されます。Red Hat Ceph Storage ダッシュボードに初めてログインするときにパスワードを変更する必要があります。ダッシュボードを使用して、admin ユーザーのパスワードを変更できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

手順

ダッシュボードにログインします。

構文

https://HOST_NAME:8443

https://HOST_NAME:8443Copy to Clipboard Copied! Toggle word wrap Toggle overflow - メニューバーの User→Change password に移動します。

- 検証するために、古いパスワードを入力してください。

- New password フィールドに新しいパスワードを入力します。パスワードは 8 文字以上でなければならず、前回のパスワードとは異なる必要があります。

- Confirm password フィールドに、確認のために新しいパスワードをもう一度入力します。

Change Password をクリックします。

ログアウトし、ログイン画面にリダイレクトされます。パスワードの変更を確認する通知が表示されます。

2.8. コマンドラインインターフェイスを使用した Ceph Dashboard のパスワードの変更

Ceph Dashboard のパスワードを忘れた場合は、コマンドラインインターフェイスを使用してパスワードを変更できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ダッシュボードがインストールされているホストへの root レベルのアクセス。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow dashboard_password.ymlファイルを作成します。例

[ceph: root@host01 /]# touch dashboard_password.yml

[ceph: root@host01 /]# touch dashboard_password.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを編集し、新しいダッシュボードパスワードを追加します。

例

[ceph: root@host01 /]# vi dashboard_password.yml

[ceph: root@host01 /]# vi dashboard_password.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ダッシュボードのパスワードをリセットします。

構文

ceph dashboard ac-user-set-password DASHBOARD_USERNAME -i PASSWORD_FILE

ceph dashboard ac-user-set-password DASHBOARD_USERNAME -i PASSWORD_FILECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph dashboard ac-user-set-password admin -i dashboard_password.yml {"username": "admin", "password": "$2b$12$i5RmvN1PolR61Fay0mPgt.GDpcga1QpYsaHUbJfoqaHd1rfFFx7XS", "roles": ["administrator"], "name": null, "email": null, "lastUpdate": , "enabled": true, "pwdExpirationDate": null, "pwdUpdateRequired": false}[ceph: root@host01 /]# ceph dashboard ac-user-set-password admin -i dashboard_password.yml {"username": "admin", "password": "$2b$12$i5RmvN1PolR61Fay0mPgt.GDpcga1QpYsaHUbJfoqaHd1rfFFx7XS", "roles": ["administrator"], "name": null, "email": null, "lastUpdate": , "enabled": true, "pwdExpirationDate": null, "pwdUpdateRequired": false}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

- 新しいパスワードでダッシュボードにログインします。

2.9. Grafana の admin ユーザーパスワードの設定

デフォルトでは、cephadm は Grafana の管理者ユーザーを作成しません。Ceph Orchestrator を使用すると、管理者ユーザーを作成してパスワードを設定できます。

これらの認証情報を使用すると、管理者ユーザーに指定されたパスワードを使用して、ストレージクラスターの Grafana URL にログインできます。

前提条件

- モニタリングスタックがインストールされた実行中の Red Hat Ceph Storage クラスターがある。

-

cephadmホストへの root レベルのアクセスがある。 -

dashboardモジュールが有効化されている。

手順

root ユーザーとして

grafana.ymlファイルを作成し、次の詳細を指定します。構文

service_type: grafana spec: initial_admin_password: PASSWORD

service_type: grafana spec: initial_admin_password: PASSWORDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

service_type: grafana spec: initial_admin_password: mypassword

service_type: grafana spec: initial_admin_password: mypasswordCopy to Clipboard Copied! Toggle word wrap Toggle overflow grafana.ymlファイルをコンテナーのディレクトリーにマウントします。例

cephadm shell --mount grafana.yml:/var/lib/ceph/grafana.yml

[root@host01 ~]# cephadm shell --mount grafana.yml:/var/lib/ceph/grafana.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記シェルを終了するたびに、デーモンをデプロイする前にファイルをコンテナーにマウントする必要があります。

オプション:

dashboardの Ceph Manager モジュールが有効になっているかどうかを確認します。例

[ceph: root@host01 /]# ceph mgr module ls

[ceph: root@host01 /]# ceph mgr module lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow オプション:

dashboardの Ceph Manager モジュールを有効にします。例

[ceph: root@host01 /]# ceph mgr module enable dashboard

[ceph: root@host01 /]# ceph mgr module enable dashboardCopy to Clipboard Copied! Toggle word wrap Toggle overflow orchコマンドを使用して仕様を適用します。構文

ceph orch apply -i FILE_NAME.yml

ceph orch apply -i FILE_NAME.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch apply -i /var/lib/ceph/grafana.yml

[ceph: root@host01 /]# ceph orch apply -i /var/lib/ceph/grafana.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow grafanaサービスを再デプロイします。例

[ceph: root@host01 /]# ceph orch redeploy grafana

[ceph: root@host01 /]# ceph orch redeploy grafanaCopy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、指定されたパスワードで

adminという名前の管理者ユーザーが作成され、ユーザーはこれらの認証情報を使用して Grafana URL にログインできます。

検証:

次の認証情報を使用して Grafana にログインします。

構文

https://HOST_NAME:PORT

https://HOST_NAME:PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

https://host01:3000/

https://host01:3000/Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.10. Red Hat Ceph Storage Dashboard を手動で有効にする

ブートストラップ中に --skip-dashboard オプションを使用して Red Hat Ceph Storage クラスターをインストールした場合は、ダッシュボードの URL と認証情報がブートストラップ出力で使用できないことが確認できます。コマンドラインインターフェイスを使用して、ダッシュボードを手動で有効にできます。Prometheus、Grafana、Alertmanager、node-exporter などの監視スタックコンポーネントはデプロイされていますが、これらは無効になっているため、手動で有効にする必要があります。

前提条件

-

ブートストラップ中に

--skip-dashboardオプションを指定してインストールされた実行中の Red Hat Ceph Storage クラスター。 - ダッシュボードを有効にする必要があるホストへの root レベルのアクセス。

手順

Cephadm シェルにログインします。

例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph Manager サービスを確認します。

例

[ceph: root@host01 /]# ceph mgr services { "prometheus": "http://10.8.0.101:9283/" }[ceph: root@host01 /]# ceph mgr services { "prometheus": "http://10.8.0.101:9283/" }Copy to Clipboard Copied! Toggle word wrap Toggle overflow ダッシュボードの URL が設定されていないことが確認できます。

ダッシュボードモジュールを有効にします。

例

[ceph: root@host01 /]# ceph mgr module enable dashboard

[ceph: root@host01 /]# ceph mgr module enable dashboardCopy to Clipboard Copied! Toggle word wrap Toggle overflow ダッシュボードアクセス用の自己署名証明書を作成します。

例

[ceph: root@host01 /]# ceph dashboard create-self-signed-cert

[ceph: root@host01 /]# ceph dashboard create-self-signed-certCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記証明書の検証を無効にして、証明書のエラーを回避できます。

Ceph Manager サービスを確認します。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Ceph Storage ダッシュボードにアクセスするための管理者ユーザーとパスワードを作成します。

構文

echo -n "PASSWORD" > PASSWORD_FILE ceph dashboard ac-user-create admin -i PASSWORD_FILE administrator

echo -n "PASSWORD" > PASSWORD_FILE ceph dashboard ac-user-create admin -i PASSWORD_FILE administratorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# echo -n "p@ssw0rd" > password.txt [ceph: root@host01 /]# ceph dashboard ac-user-create admin -i password.txt administrator

[ceph: root@host01 /]# echo -n "p@ssw0rd" > password.txt [ceph: root@host01 /]# ceph dashboard ac-user-create admin -i password.txt administratorCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 監視スタックを有効にします。詳細は、Red Hat Ceph Storage ダッシュボードガイド の モニタリングスタックの有効化 セクションを参照してください。

2.11. Ceph Dashboard にユーザーを同期するための管理者アカウントの作成

ユーザーを Ceph Dashboard に同期するには、管理者アカウントを作成する必要があります。

アカウントを作成したら、Red Hat シングルサインオン (SSO) を使用して、ユーザーを Ceph Dashboard と同期させます。Red Hat Ceph Storage ダッシュボードガイド の Red Hat Single Sign-On を使用してユーザーを Ceph ダッシュボードに同期する セクションを参照してください。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ダッシュボードへの管理者レベルのアクセス権。

- ユーザーをダッシュボードに追加しておく。

- すべてのホストでの root レベルのアクセス。

- Java OpenJDK がインストールされている。詳細は、Red Hat カスタマーポータルで、OpenJDK の RHEL 向け OpenJDK 8 のインストールおよび使用 ガイドの yum を使用した RHEL への JRE のインストール セクションを参照してください。

- Red hat Single Sign-On を ZIP ファイルからインストールしておく。Red Hat カスタマーポータルで、Red Hat Single Sign-On の サーバーインストールおよび設定ガイド の ZIP ファイルからの RH-SSO のインストール セクションを参照してください。

手順

- Red Hat Ceph ストレージがインストールされているシステムに Red Hat Single Sign-On 7.4.0 サーバー をダウンロードします。

フォルダーをデプロイメントします。

unzip rhsso-7.4.0.zip

[root@host01 ~]# unzip rhsso-7.4.0.zipCopy to Clipboard Copied! Toggle word wrap Toggle overflow standalone/configurationディレクトリーに移動し、standalone.xmlを開いて編集します。cd standalone/configuration vi standalone.xml

[root@host01 ~]# cd standalone/configuration [root@host01 configuration]# vi standalone.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 新しく作成された

rhsso-7.4.0フォルダーのbinディレクトリーから、add-user-keycloakスクリプトを実行して初期管理者ユーザーを追加します。./add-user-keycloak.sh -u admin

[root@host01 bin]# ./add-user-keycloak.sh -u adminCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

localhostのすべてのインスタンスと127.0.0.1の 2 つのインスタンスは、Red Hat SSO がインストールされているマシンの IP アドレスに置き換えます。 サービスを起動します。

rh-sso-7.4フォルダーのbinディレクトリーから、standaloneブートスクリプトを実行します。./standalone.sh

[root@host01 bin]# ./standalone.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow ユーザー名とパスワードを指定して、https: IP_ADDRESS :8080/auth で管理アカウントを作成します。

注記管理者アカウントは、コンソールへの初回ログイン時に作成にのみ作成する必要があります。

- 作成された認証情報を使用して管理コンソールにログインします。

2.12. Red Hat シングルサインオンを使用したユーザーの Ceph Dashboard への同期

Red Hat シングルサインオン (SSO) と Lightweight Directory Access Protocol (LDAP) 統合を使用して、ユーザーを Red Hat Ceph ストレージダッシュボードと同期させることができます。

ユーザーは特定のレルムに追加されます。このレルムでは、パスワードの追加要件なしで SSO を介してダッシュボードにアクセスできます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ダッシュボードへの管理者レベルのアクセス権。

- ユーザーをダッシュボードに追加しておく。Red Hat Ceph Storage ダッシュボードガイド の Ceph ダッシュボードでのユーザーの作成 セクションを参照してください。

- すべてのホストでの root レベルのアクセス。

- ユーザーの同期用に作成された管理者アカウント。Red Hat Ceph Storage ダッシュボードガイド の ユーザーを Ceph ダッシュボードに同期するための管理者アカウントの作成 セクションを参照してください。

手順

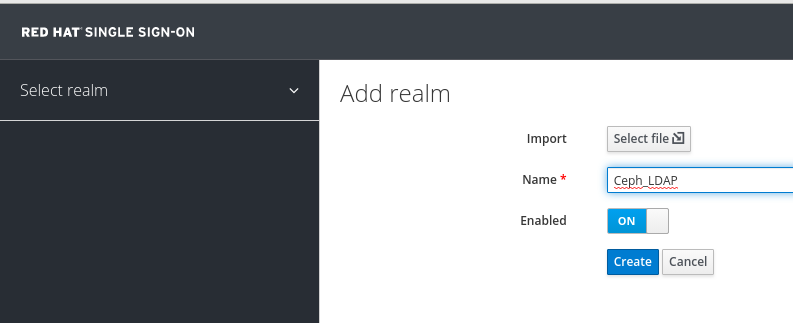

- レルムを作成するには、Master ドロップダウンメニューをクリックします。このレルムでは、ユーザーおよびアプリケーションにアクセスできます。

Add Realm ウィンドウで、レルム名 (大文字と小文字を区別) を入力し、パラメーターを Enabled に設定し、Create をクリックします。

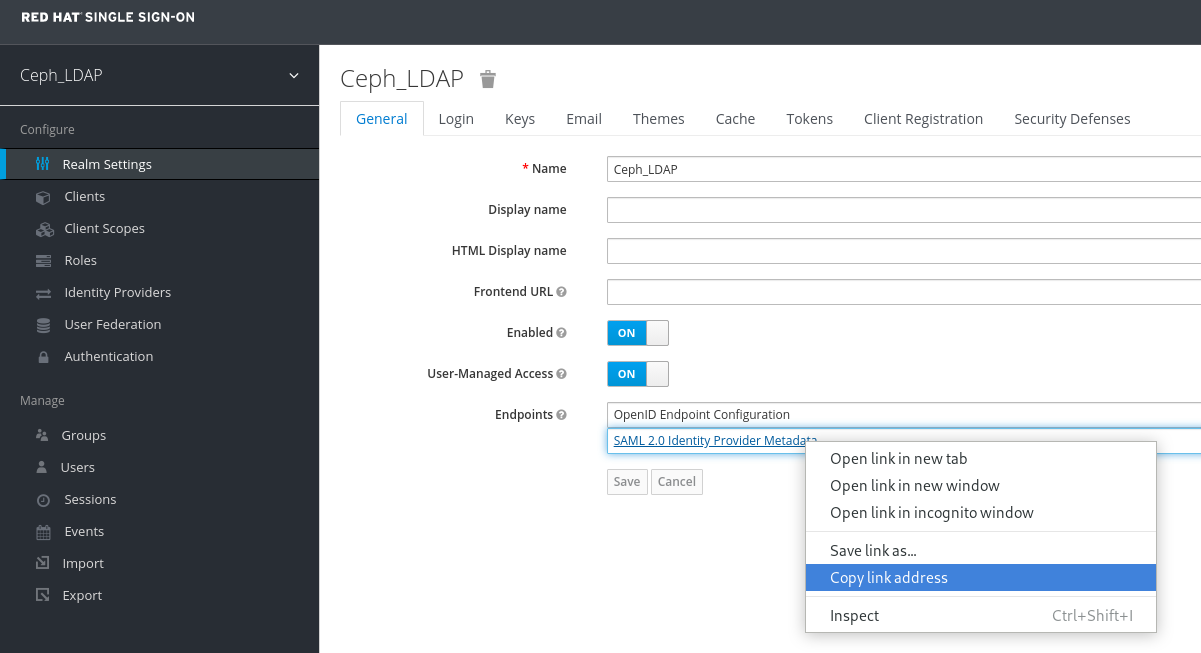

Realm Settings タブで、次のパラメーターを設定し、Save をクリックします。

- Enabled - ON

- User-Managed Access - ON

Client Settings に貼り付ける SAML 2.0 アイデンティティープロバイダーメタデータのリンクアドレスをメモしておきます。

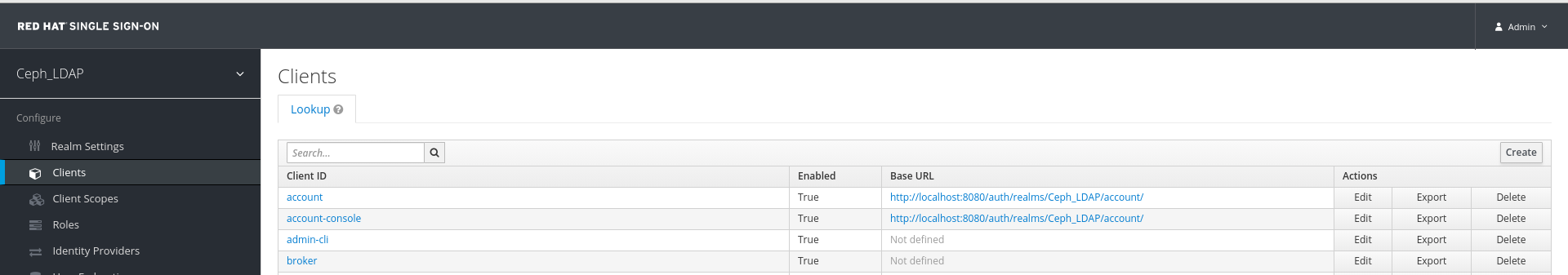

Clients タブで、Create をクリックします。

Add Client ウィンドウで、次のパラメーターを設定し、Save をクリックします。

クライアント ID - BASE_URL:8443/auth/saml2/metadata

例

https://example.ceph.redhat.com:8443/auth/saml2/metadata

- クライアントプロトコル - saml

Client ウィンドウの Settings タブで、次のパラメーターを設定します。

Expand 表2.2 クライアント設定タブ パラメーターの名前 構文 例 Client IDBASE_URL:8443/auth/saml2/metadata

https://example.ceph.redhat.com:8443/auth/saml2/metadata

EnabledON

ON

クライアントプロトコルsaml

saml

Include AuthnStatementON

ON

サインインドキュメントON

ON

Signature AlgorithmRSA_SHA1

RSA_SHA1

SAML Signature Key NameKEY_ID

KEY_ID

有効なリダイレクト URLBASE_URL:8443/*

https://example.ceph.redhat.com:8443/*

ベース URLBASE_URL:8443

https://example.ceph.redhat.com:8443/

Master SAML Processing URLhttps://localhost:8080/auth/realms/REALM_NAME/protocol/saml/descriptor

https://localhost:8080/auth/realms/Ceph_LDAP/protocol/saml/descriptor

注記Realm Settings タブから SAML 2.0 アイデンティティープロバイダーメタデータのリンクを貼り付けます。

Fine Grain SAML Endpoint Configuration で、次のパラメーターを設定し、Save をクリックします。

Expand 表2.3 詳細にわたる SAML 設定 パラメーターの名前 構文 例 Assertion Consumer Service POST Binding URL

BASE_URL:8443/#/dashboard

https://example.ceph.redhat.com:8443/#/dashboard

Assertion Consumer Service Redirect Binding URL

BASE_URL:8443/#/dashboard

https://example.ceph.redhat.com:8443/#/dashboard

Logout Service Redirect Binding URL

BASE_URL:8443/

https://example.ceph.redhat.com:8443/

Clients ウィンドウの Mappers タブで、次のパラメーターを設定し、Save をクリックします。

Expand 表2.4 クライアントマッパータブ パラメーターの名前 値 プロトコルsaml

名前username

マッパープロパティーユーザープロパティー

プロパティーusername

SAML 属性名username

Clients Scope タブで、role_list を選択します。

- Mappers タブで、role list を選択し、Single Role Attribute をオンに設定します。

User_Federation タブを選択します。

- User Federation ウィンドウで、ドロップダウンメニューから LDAP を選択します。

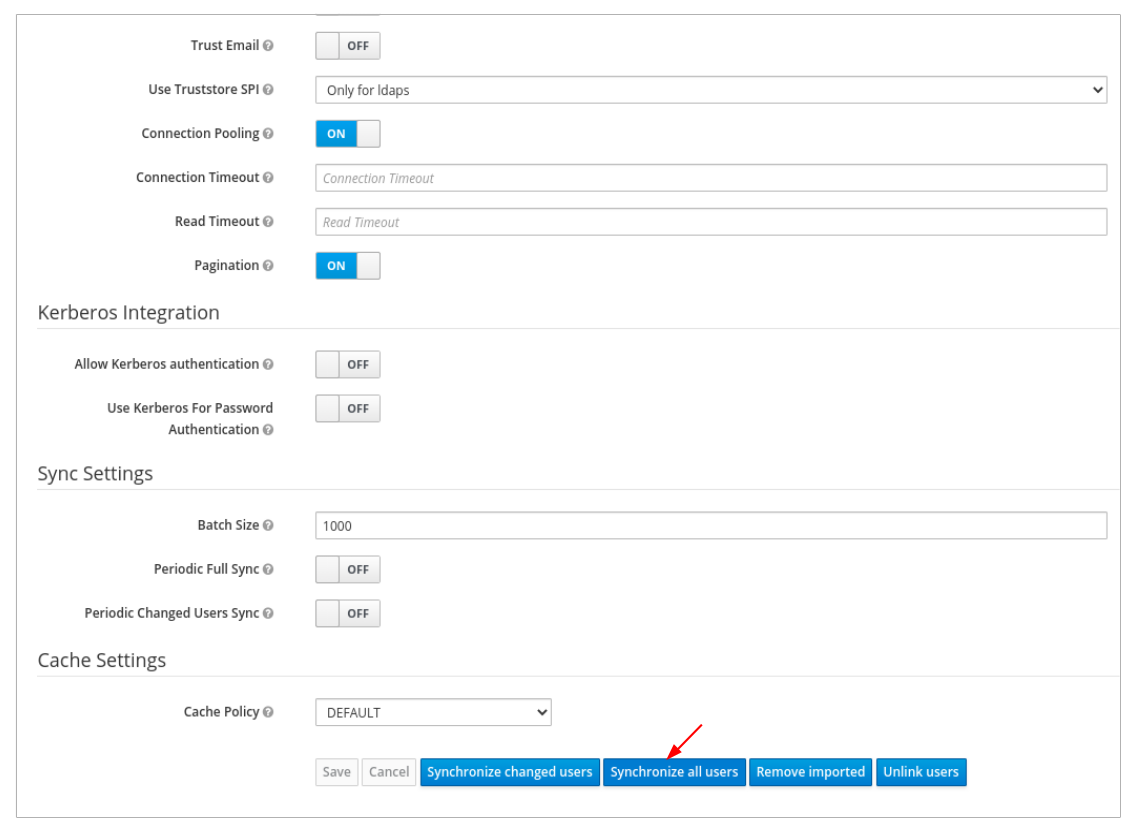

User_Federation ウィンドウの Settings タブで、次のパラメーターを設定し、Save をクリックします。

Expand 表2.5 ユーザーフェデレーション設定タブ パラメーターの名前 値 コンソール表示名rh-ldap

ユーザーのインポートON

Edit_ModeREAD_ONLY

ユーザー名 LDAP 属性username

RDN LDAP 属性username

UUID LDAP 属性nsuniqueid

ユーザーオブジェクトクラスinetOrgPerson, organizationalPerson, rhatPerson

接続 URL例: ldap: //ldap.corp.redhat.com。Test Connection をクリックします。LDAP 接続が成功したという通知が表示されます。

ユーザー DNou=users、dc=example、dc=com

バインドタイプsimple

Test authentication をクリックします。LDAP 認証が成功したという通知が表示されます。

Mappers タブで、first name の行を選択して、以下のパラメーターを編集し、Save をクリックします。

- LDAP 属性 - givenName

User_Federation タブの Settings タブで、Synchronize all users をクリックします。

ユーザーの同期が正常に終了したという通知が表示されます。

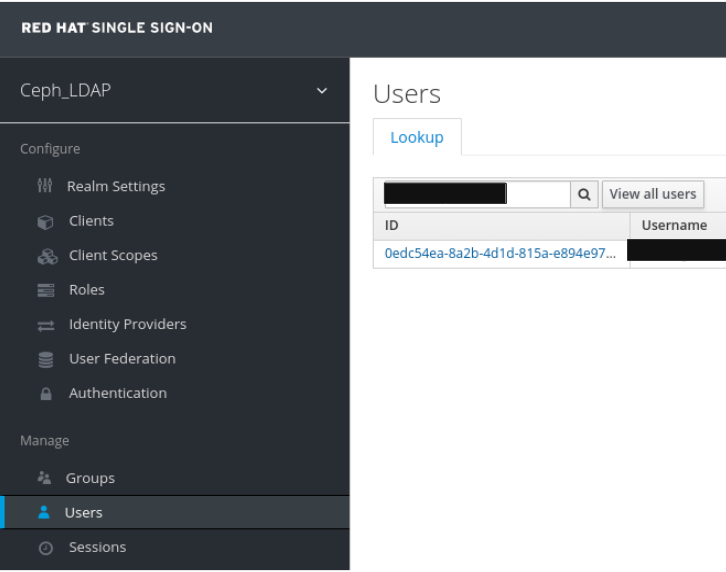

Users タブで、ダッシュボードに追加されたユーザーを検索し、検索アイコンをクリックします。

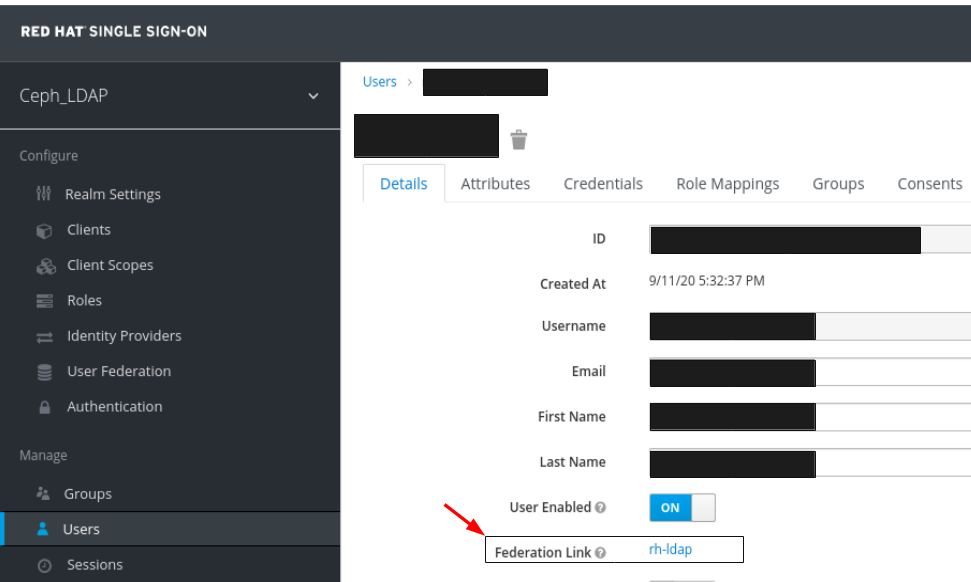

ユーザーを表示するには、特定の行をクリックします。フェデレーションリンクは、User Federation で指定した名前で表示されます。

重要

重要ユーザーは LDAP では同期されないため、手動でユーザーを追加しないでください。手動で追加した場合は、Delete をクリックしてユーザーを削除します。

注記現在、作業環境内で Red Hat SSO を使用している場合は、まず SSO を有効にします。詳細は、Red Hat Ceph Storage Dashboard Guide の Ceph Dashboard のシングルサインオンの有効化 セクションを参照してください。

検証

レルムとダッシュボードに追加されたユーザーは、メールアドレスとパスワードを使用して Ceph Dashboard にアクセスできます。

例

https://example.ceph.redhat.com:8443

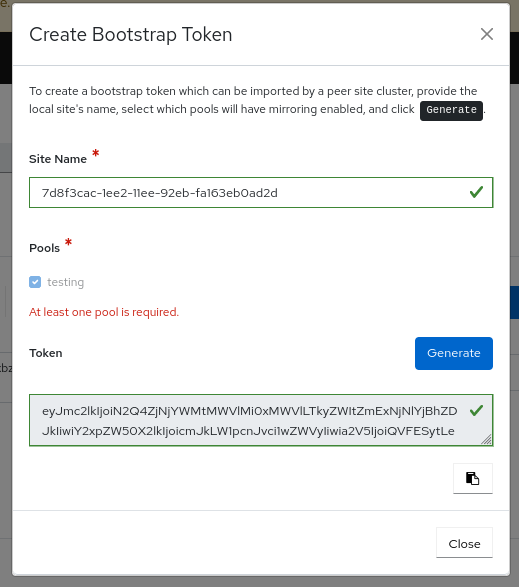

2.13. Ceph Dashboard のシングルサインオンの有効化

Ceph Dashboard は、Security Assertion Markup Language (SAML) 2.0 プロトコルを使用したユーザーの外部認証をサポートします。Ceph Dashboard にシングルサインオン (SSO) を使用する前に、ダッシュボードのユーザーアカウントを作成して必要なロールを割り当てます。Ceph Dashboard はユーザーの承認を実行し、認証プロセスは既存のアイデンティティープロバイダー (IdP) によって実行されます。SAML プロトコルを使用してシングルサインオンを有効にできます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Ceph Dashboard のインストール。

- Ceph Manager ホストへの root レベルのアクセス。

手順

Ceph Dashboard で SSO を設定するには、以下のコマンドを実行します。

構文

cephadm shell CEPH_MGR_HOST ceph dashboard sso setup saml2 CEPH_DASHBOARD_BASE_URL IDP_METADATA IDP_USERNAME_ATTRIBUTE IDP_ENTITY_ID SP_X_509_CERT SP_PRIVATE_KEY

cephadm shell CEPH_MGR_HOST ceph dashboard sso setup saml2 CEPH_DASHBOARD_BASE_URL IDP_METADATA IDP_USERNAME_ATTRIBUTE IDP_ENTITY_ID SP_X_509_CERT SP_PRIVATE_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

cephadm shell host01 ceph dashboard sso setup saml2 https://dashboard_hostname.ceph.redhat.com:8443 idp-metadata.xml username https://10.70.59.125:8080/auth/realms/realm_name /home/certificate.txt /home/private-key.txt

[root@host01 ~]# cephadm shell host01 ceph dashboard sso setup saml2 https://dashboard_hostname.ceph.redhat.com:8443 idp-metadata.xml username https://10.70.59.125:8080/auth/realms/realm_name /home/certificate.txt /home/private-key.txtCopy to Clipboard Copied! Toggle word wrap Toggle overflow 置き換え

-

CEPH_MGR_HOST と Ceph

mgrホスト。(例:host01) - CEPH_DASHBOARD_BASE_URL は、Ceph Dashboard がアクセス可能なベース URL に置き換えます。

- IDP_METADATA は、リモートパスまたはローカルパス、または IdP メタデータ XML の内容への URL に置き換えます。サポートされる URL タイプは http、https、およびファイルです。

- 任意: IDP_USERNAME_ATTRIBUTE は、認証応答からユーザー名を取得するために使用される属性に置き換えます。デフォルトは uid です。

- 任意: IDP_ENTITY_ID は、IdP メタデータに複数のエンティティー ID が存在する場合は IdP エンティティー ID に置き換えます。

- 任意: SP_X_509_CERT は、署名および暗号化に Ceph Dashboard によって使用される証明書のファイルパスに置き換えます。

- 任意: SP_PRIVATE_KEY は、署名および暗号化に Ceph Dashboard によって使用される秘密鍵のファイルパスに置き換えます。

-

CEPH_MGR_HOST と Ceph

現在の SAML 2.0 設定を確認します。

構文

cephadm shell CEPH_MGR_HOST ceph dashboard sso show saml2

cephadm shell CEPH_MGR_HOST ceph dashboard sso show saml2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

cephadm shell host01 ceph dashboard sso show saml2

[root@host01 ~]# cephadm shell host01 ceph dashboard sso show saml2Copy to Clipboard Copied! Toggle word wrap Toggle overflow SSO を有効にするには、以下のコマンドを実行します。

構文

cephadm shell CEPH_MGR_HOST ceph dashboard sso enable saml2 SSO is "enabled" with "SAML2" protocol.

cephadm shell CEPH_MGR_HOST ceph dashboard sso enable saml2 SSO is "enabled" with "SAML2" protocol.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

cephadm shell host01 ceph dashboard sso enable saml2

[root@host01 ~]# cephadm shell host01 ceph dashboard sso enable saml2Copy to Clipboard Copied! Toggle word wrap Toggle overflow ダッシュボードの URL を開きます。

例

https://dashboard_hostname.ceph.redhat.com:8443

https://dashboard_hostname.ceph.redhat.com:8443Copy to Clipboard Copied! Toggle word wrap Toggle overflow - SSO ページで、ログインの認証情報を入力します。SSO はダッシュボードの Web インターフェイスにリダイレクトされます。

2.14. Ceph Dashboard のシングルサインオンの無効化

SAML 2.0 プロトコルを使用して、Ceph Dashboard のシングルサインオンを無効にすることができます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Ceph Dashboard のインストール。

- Ceph Manager ホストへの root レベルのアクセス。

- Ceph Dashboard で有効になっているシングルサインオン

手順

SSO の状態を表示するには、以下のコマンドを実行します。

構文

cephadm shell CEPH_MGR_HOST ceph dashboard sso status

cephadm shell CEPH_MGR_HOST ceph dashboard sso statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

cephadm shell host01 ceph dashboard sso status SSO is "enabled" with "SAML2" protocol.

[root@host01 ~]# cephadm shell host01 ceph dashboard sso status SSO is "enabled" with "SAML2" protocol.Copy to Clipboard Copied! Toggle word wrap Toggle overflow SSO を無効にするには、以下のコマンドを実行します。

構文

cephadm shell CEPH_MGR_HOST ceph dashboard sso disable SSO is "disabled".

cephadm shell CEPH_MGR_HOST ceph dashboard sso disable SSO is "disabled".Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

cephadm shell host01 ceph dashboard sso disable

[root@host01 ~]# cephadm shell host01 ceph dashboard sso disableCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第3章 Ceph Dashboard でのロールの管理

ストレージ管理者は、ダッシュボードでロールを作成、編集、複製、削除できます。

デフォルトでは、8 つのシステムロールがあります。カスタムロールを作成し、それらのロールにアクセス権を付与できます。これらのロールは、要件に基づいてユーザーに割り当てることができます。

このセクションでは、以下の管理タスクを説明します。

3.1. Ceph Dashboard 上のユーザーロールとパーミッション

ユーザーアカウントは、アクセス可能な特定のダッシュボード機能を定義するロールのセットに関連付けられます。

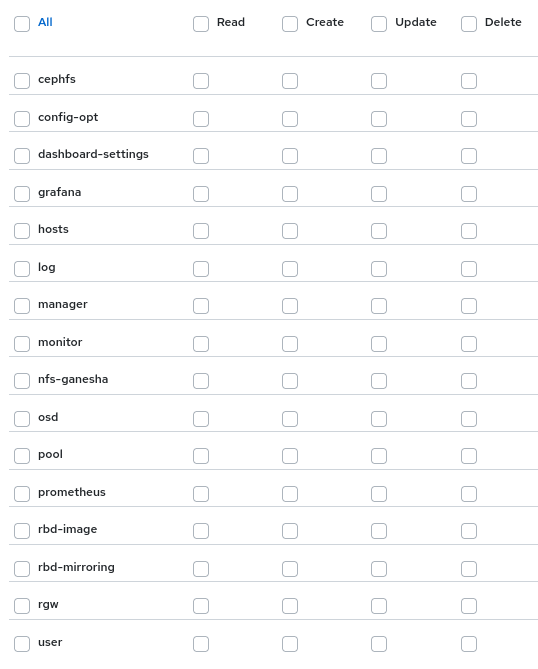

Red Hat Ceph Storage ダッシュボードの機能またはモジュールは、セキュリティースコープ内でグループ化されます。セキュリティースコープは事前に定義され、静的です。Red Hat Ceph Storage ダッシュボードで現在利用可能な セキュリティースコープ は以下のとおりです。

- cephfs: CephFS 管理に関連するすべての機能が含まれます。

- config-opt: Ceph 設定オプションの管理に関連するすべての機能が含まれます。

- dashboard-settings: ダッシュボード設定を編集することができます。

- grafana: Grafana プロキシーに関連するすべての機能が含まれます。

- hosts: Hosts メニューエントリーに関連するすべての機能が含まれます。

- log: Ceph ログ管理に関するすべての機能が含まれます。

- manager: Ceph Manager 管理に関連するすべての機能が含まれます。

- monitor: Ceph monitor 管理に関連するすべての機能が含まれます。

- nfs-ganesha: NFS-Ganesha 管理に関連するすべての機能が含まれます。

- osd: OSD 管理に関連するすべての機能が含まれます。

- pool: プール管理に関連するすべての機能が含まれます。

- prometheus: Prometheus アラート管理に関連するすべての機能が含まれます。

- rbd-image: RBD イメージ管理に関連するすべての機能が含まれます。

- rbd-mirroring: RBD ミラーリング管理に関連するすべての機能が含まれます。

- rgw: Ceph Object Gateway (RGW) 管理に関連するすべての機能が含まれます。

ロールはセキュリティースコープとパーミッションのセット間のマッピングのセットを指定します。パーミッション には 4 つのタイプがあります。

- 読み取り

- Create

- Update

- 削除

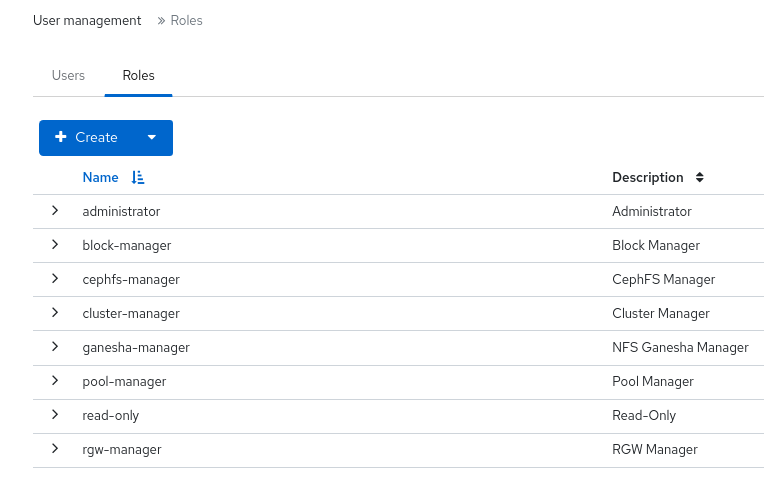

システムロール のリストは以下のとおりです。

- administrator: すべてのセキュリティースコープの完全なパーミッションを許可します。

- block-manager: RBD-image および RBD-mirroring スコープのフルパーミッションを許可します。

- cephfs-manager: Ceph ファイルシステムのスコープのフルパーミッションを許可します。

- cluster-manager: ホスト、OSD、モニター、マネージャー、および config-opt スコープのフルパーミッションを許可します。

- ganesha-manager: NFS-Ganesha スコープのフルパーミッションを許可します。

- pool-manager: プールスコープのフルパーミッションを許可します。

- read-only: ダッシュボード設定および config-opt スコープ以外のすべてのセキュリティースコープの読み取りパーミッションを許可します。

- rgw-manager: Ceph Object Gateway スコープのフルパーミッションを許可します。

たとえば、すべての Ceph Object Gateway 操作についてユーザーに rgw-manager アクセスを提供する必要があります。

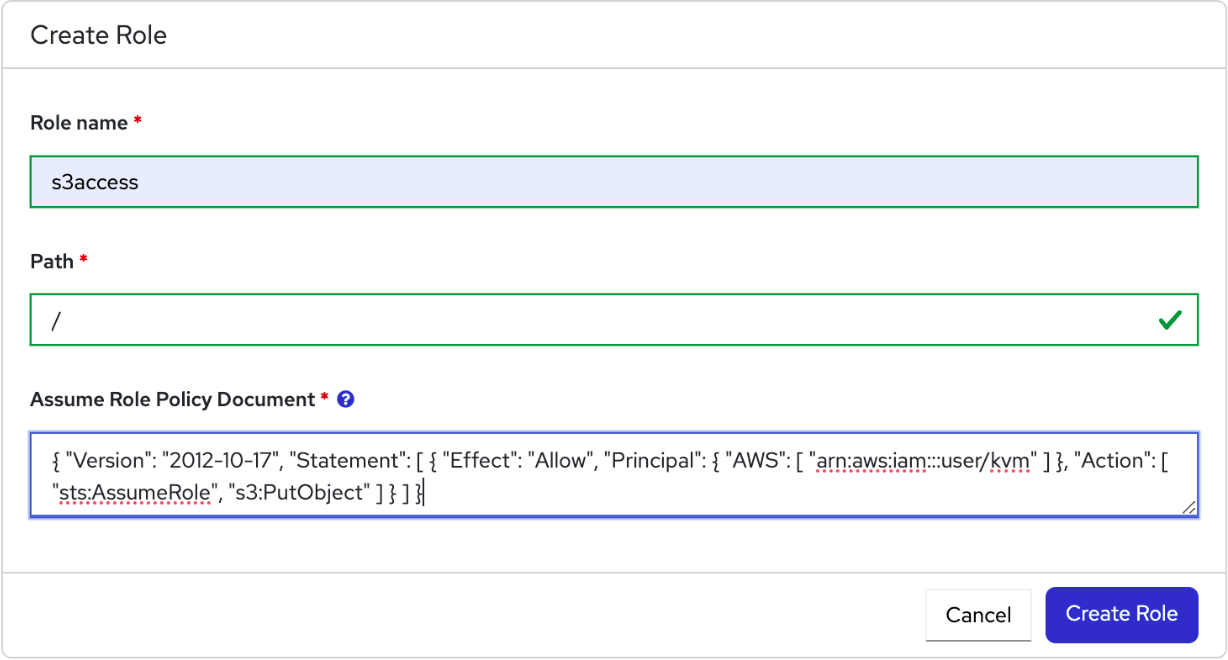

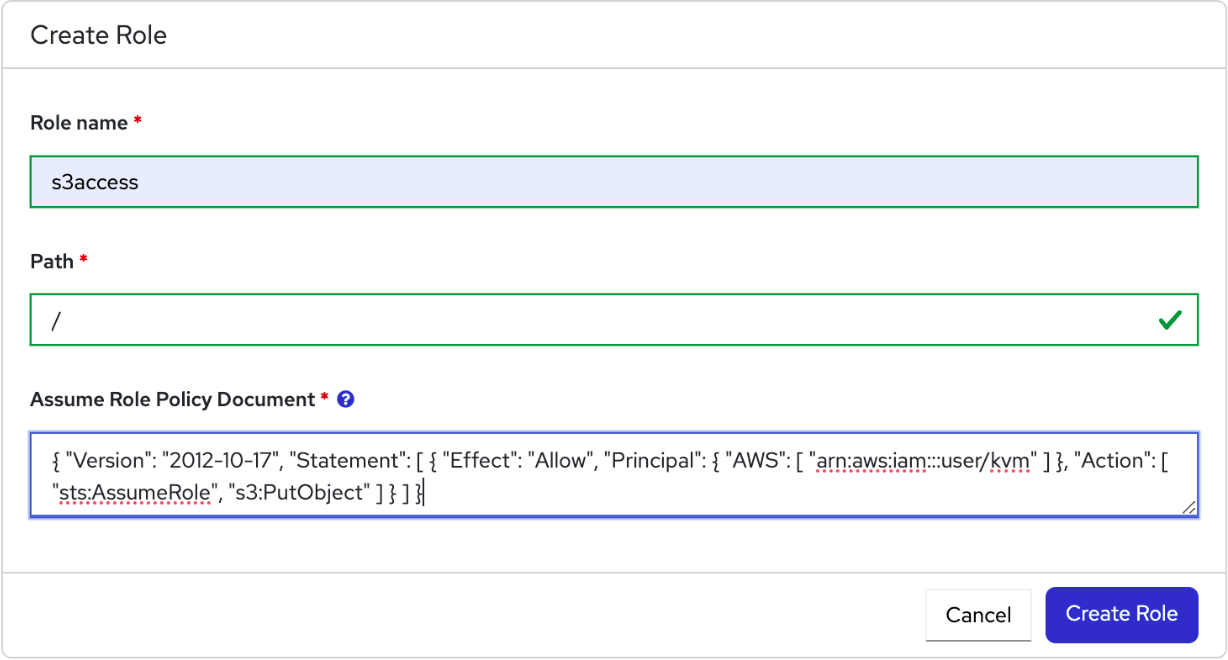

3.2. Ceph Dashboard でのロールの作成

ダッシュボードでカスタムロールを作成し、ロールに基づいてこれらのロールをユーザーに割り当てることができます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ダッシュボードへの管理者レベルのアクセス権。

手順

- ダッシュボードにログインします。

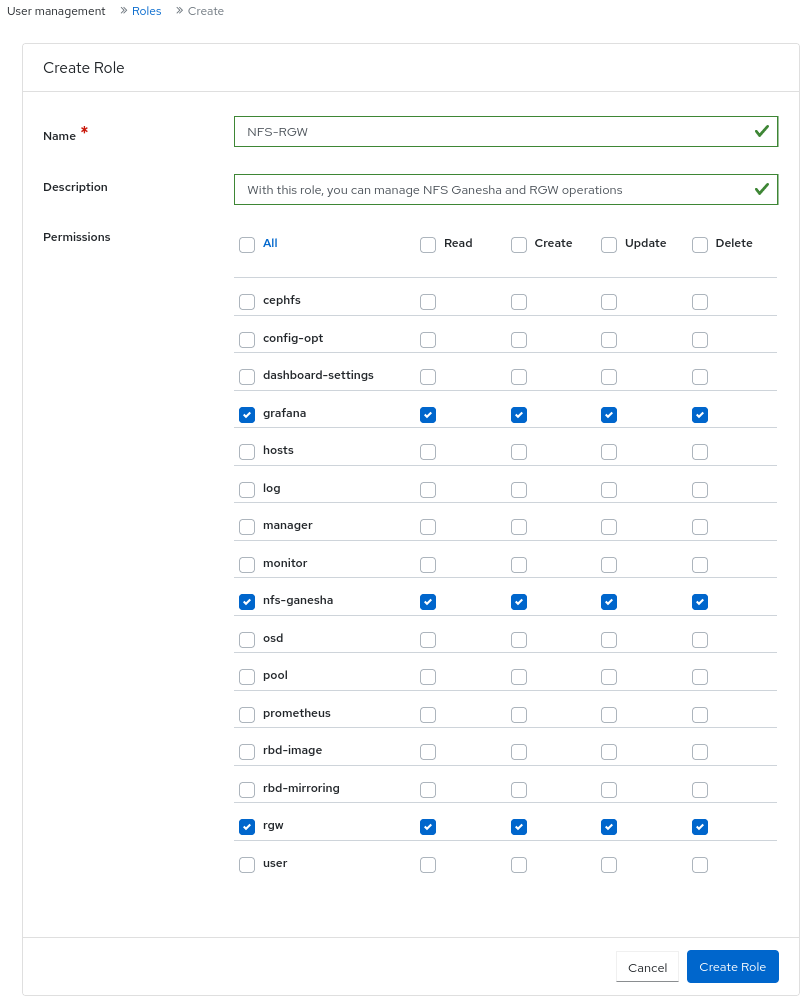

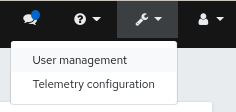

ダッシュボードの設定 アイコンをクリックし、User management をクリックします。

- Roles タブで、Create をクリックします。

Create Role ウィンドウで、Name、Description を設定し、このロールの Permissions を選択して、Create Role ボタンをクリックします。

この例では、

ganesha-managerおよびrgw-managerのロールが割り当てられたユーザーは、すべての NFS-Ganesha ゲートウェイおよび Ceph Object Gateway の操作を管理できます。- ロールが正常に作成されたという通知が表示されます。

- その行の Expand/Collapse アイコンをクリックして、ロールに付与された詳細と権限を表示します。

3.3. Ceph Dashboard でのロールの編集

ダッシュボードでは、ダッシュボードのロールを編集できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ダッシュボードへの管理者レベルのアクセス権。

- ダッシュボードでロールが作成されます。

手順

- ダッシュボードにログインします。

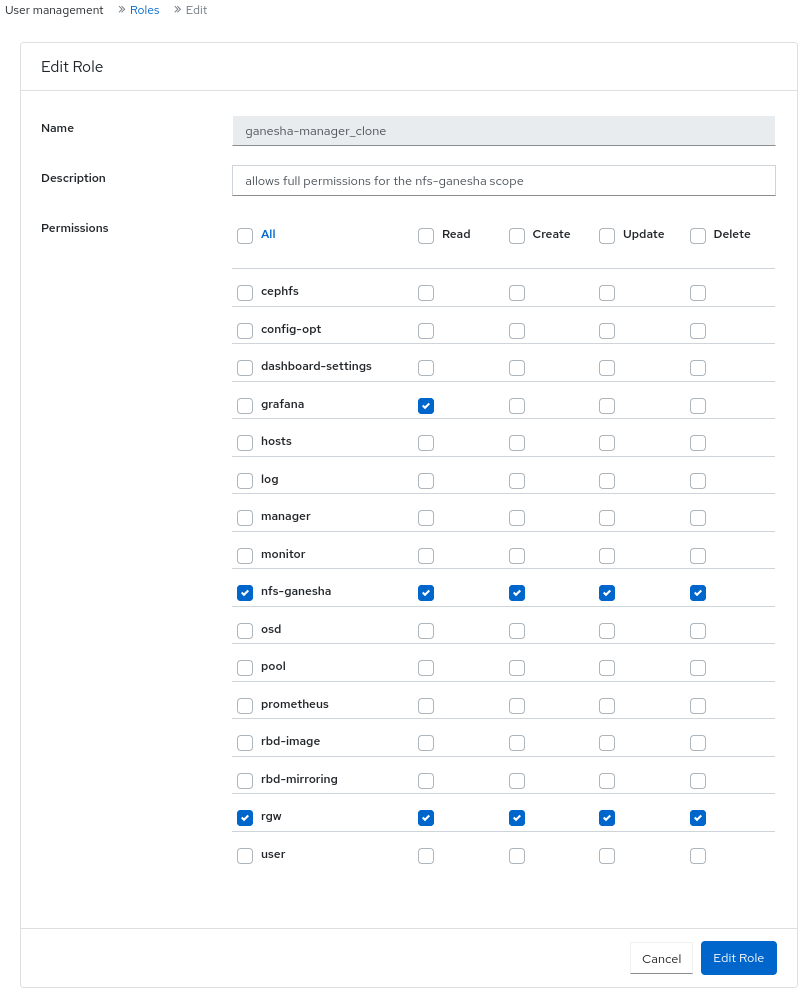

ダッシュボードの設定 アイコンをクリックし、User management をクリックします。

- Roles タブで、編集するロールをクリックします。

Edit Role ウィンドウで、パラメーターを編集し、Edit Role をクリックします。

- ロールが正常に更新されたという通知が表示されます。

3.4. Ceph Dashboard でのロールのクローン作成

既存のロールに追加の権限を割り当てる場合は、システムロールのクローンを作成し、Red Hat Ceph Storage Dashboard で編集できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ダッシュボードへの管理者レベルのアクセス権。

- ロールがダッシュボードに作成されている。

手順

- ダッシュボードにログインします。

ダッシュボードの設定 アイコンをクリックし、User management をクリックします。

- Roles タブで、クローンを作成するロールをクリックします。

- Edit ドロップダウンメニューから Clone を選択します。

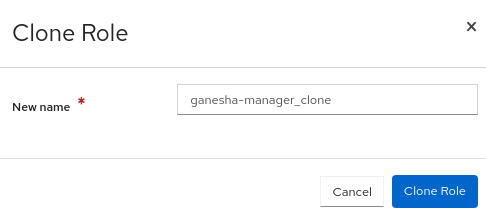

Clone Role ダイアログボックスで、ロールの詳細を入力し、Clone Role をクリックします。

- ロールを複製すると、要件に従って権限をカスタマイズできます。

3.5. Ceph Dashboard でのロールの削除

Red Hat Ceph Storage Dashboard で作成したカスタムロールは削除できます。

Ceph Dashboard のシステムロールは削除できません。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ダッシュボードへの管理者レベルのアクセス権。

- カスタムロールがダッシュボードで作成されている。

手順

- ダッシュボードにログインします。

Dashboard Settings アイコンをクリックし、User management を選択します。

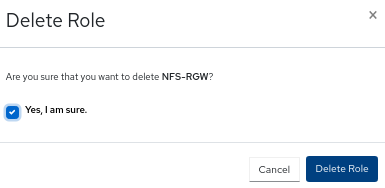

- Roles タブで、削除するロールをクリックし、アクションドロップダウンから Delete を選択します。

Delete Role 通知で Yes, I am sure を選択し、Delete Role をクリックします。

第4章 Ceph Dashboard でのユーザーの管理

ストレージ管理者は、Red Hat Ceph Storage Dashboard で特定のロールが割り当てられたユーザーを作成、編集、削除できます。ロールベースのアクセス制御は、各ユーザーのロールと要件に基づいて各ユーザーに付与されます。

ダッシュボード上で Ceph クライアント認証キーを作成、編集、インポート、エクスポート、削除することもできます。認証キーを作成したら、コマンドラインインターフェイス (CLI) を使用してキーをローテーションできます。キーのローテーションは、現在の業界要件とセキュリティーコンプライアンスの要件を満たしています。

このセクションでは、以下の管理タスクを説明します。

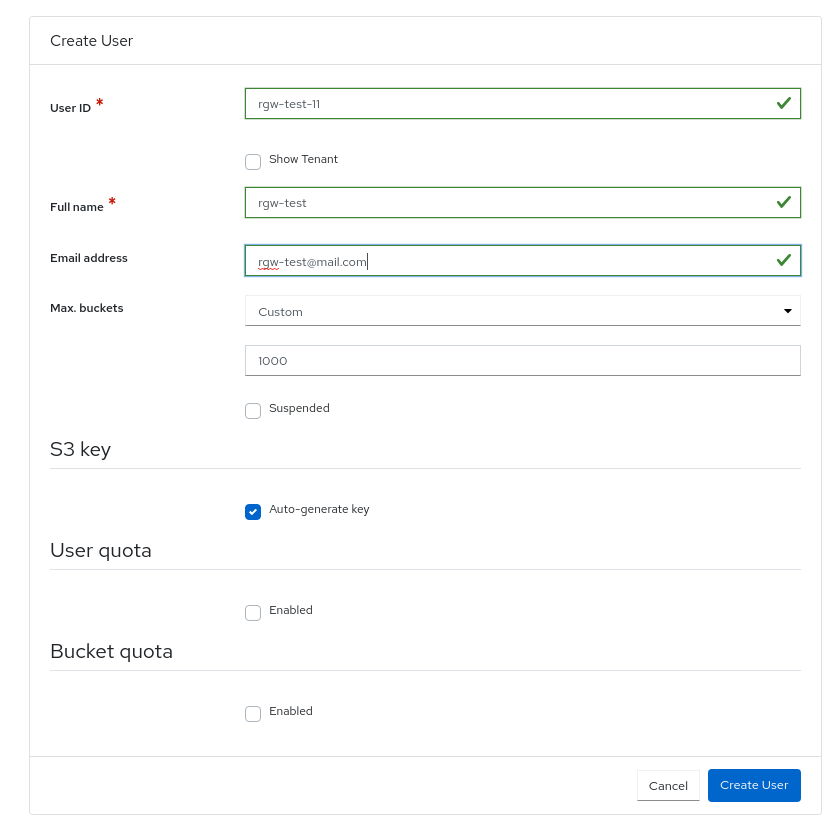

4.1. Ceph Dashboard でのユーザーの作成

Red Hat Ceph Storage Dashboard で、ロールに基づいて適切なロールと権限が割り当てられたユーザーを作成できます。たとえば、Ceph Object Gateway 操作を管理させる場合には、ユーザーに rgw-manager ロールを付与できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ダッシュボードへの管理者レベルのアクセス権。

Red Hat Ceph Storage Dashboard は、ユーザーパスワードの変更時に電子メールの検証をサポートしません。Dashboard はシングルサインオン (SSO) をサポートし、この機能を SSO プロバイダーに委譲できるため、この動作は意図的です。

手順

- ダッシュボードにログインします。

ダッシュボードの設定 アイコンをクリックし、User management をクリックします。

- Users タブで、Create をクリックします。

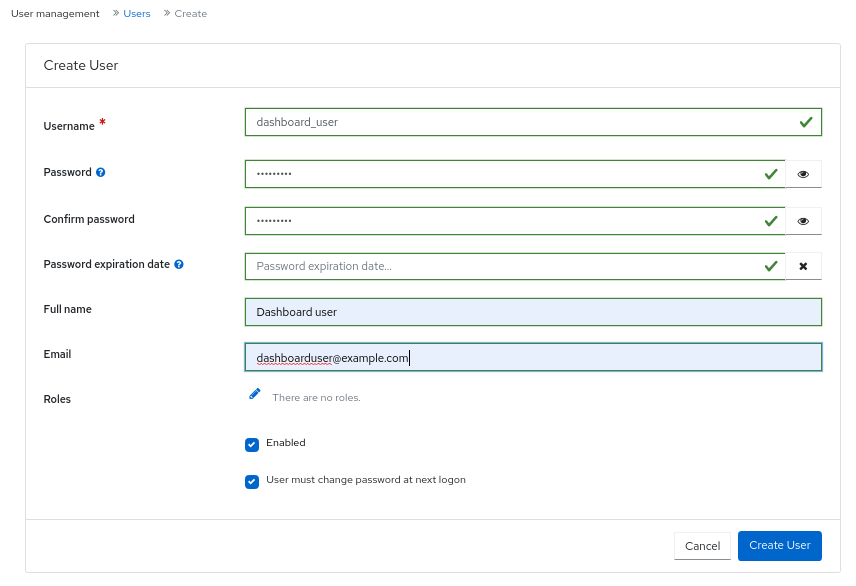

Create User ウィンドウで、Username とロールを含むその他のパラメーターを設定し、Create User をクリックします。

- ユーザーが正常に作成されたという通知が表示されます。

4.2. Ceph Dashboard でのユーザーの編集

Red Hat Ceph Storage Dashboard でユーザーを編集できます。要件に基づいて、ユーザーのパスワードとロールを変更できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ダッシュボードへの管理者レベルのアクセス権。

- ダッシュボードで作成したユーザー。

手順

- ダッシュボードにログインします。

ダッシュボードの設定 アイコンをクリックし、User management をクリックします。

- ユーザーを編集するには、行をクリックします。

- Users タブで、Edit ドロップダウンメニューから Edit を選択します。

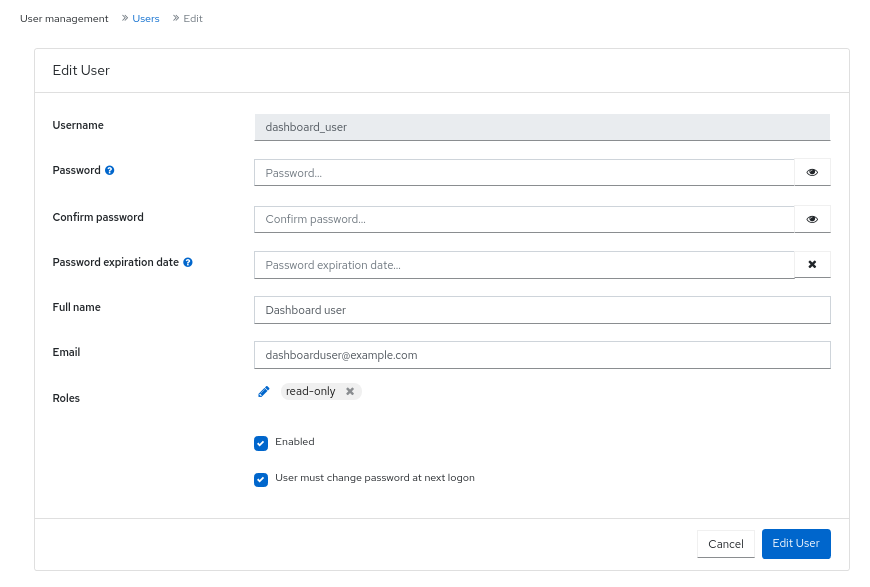

Edit User ウィンドウで、パスワードやロールなどのパラメーターを編集し、Edit User をクリックします。

注記

注記Ceph Dashboard へのユーザーのアクセスを無効にするには、Edit User ウィンドウで Enabled オプションの選択を解除します。

- ユーザーが正常に作成されたという通知が表示されます。

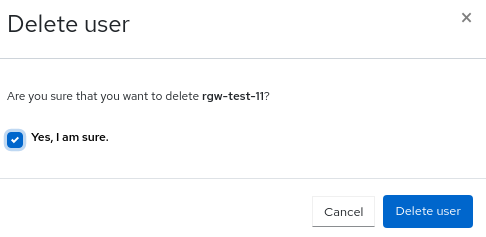

4.3. Ceph Dashboard でのユーザーの削除

Ceph Dashboard でユーザーを削除できます。一部のユーザーがシステムから削除される可能性があります。このようなユーザーへのアクセスは、Ceph Dashboard から削除できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ダッシュボードへの管理者レベルのアクセス権。

- ダッシュボードで作成したユーザー。

手順

- ダッシュボードにログインします。

ダッシュボードの設定 アイコンをクリックし、User management をクリックします。

- Users タブで、削除するユーザーをクリックします。

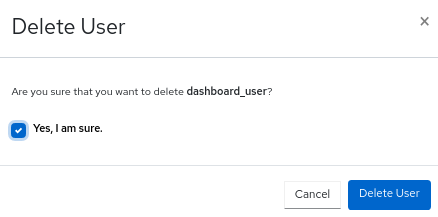

- Edit ドロップダウンメニューから Delete を選択します。

Delete User 通知で Yes, I am sure を選択し、Delete User をクリックします。

4.4. ユーザー機能

Ceph は、使用される Ceph クライアントに関係なく、データ RADOS オブジェクトをプール内に保存します。Ceph ユーザーは、データの読み取りと書き込みを行うために特定のプールにアクセスする必要があり、Ceph 管理コマンドを使用するための実行権限を持っている必要があります。ユーザーを作成すると、Red Hat Ceph Storage クラスター、そのプール、およびプール内のデータへのアクセスを制御できるようになります。

Ceph にはユーザーの type の概念があり、常に client になります。TYPE を使用してユーザーを定義する必要があります。ID ここで、ID はユーザー ID です (例: client.admin)。このユーザー入力は、Cephx プロトコルがクライアントだけでなく、Ceph モニター、OSD、メタデータサーバーなどの非クライアントでも使用されるためです。ユーザータイプを区別すると、クライアントユーザーと他のユーザーを区別するのに役立ちます。この区別により、アクセス制御、ユーザー監視、およびトレーサビリティが合理化されます。

4.4.1. ケイパビリティー

Ceph は、機能 (キャップ) を使用して、モニター、OSD、およびメタデータサーバーの機能を実行するために認証されたユーザーに付与される権限を記述します。この機能は、アプリケーションタグに基づいて、プール内のデータ、プール内の名前空間、またはプールのセットへのアクセスを制限します。Ceph 管理ユーザーは、ユーザーの作成または更新時にユーザーの機能を指定します。

モニター、マネージャー、OSD、メタデータサーバーの機能を設定できます。

-

Ceph Monitor の機能には、

r、w、およびxのアクセス設定が含まれます。これらは、profile NAMEを使用して、事前定義されたプロファイルからまとめて適用できます。 -

OSD 機能には、

r、w、x、class-read、およびclass-writeアクセス設定が含まれます。これらは、profile NAMEを使用して、事前定義されたプロファイルからまとめて適用できます。 -

Ceph Manager の機能には、

r、w、およびxのアクセス設定が含まれます。これらは、profile NAMEを使用して、事前定義されたプロファイルからまとめて適用できます。 -

管理者向けのメタデータサーバー (MDS) 機能には、

allow *が含まれます。

Ceph Object Gateway デーモン (radosgw) は Red Hat Ceph Storage クラスターのクライアントであり、Ceph Storage クラスターのデーモンタイプとしては表されません。

4.5. アクセス機能

このセクションでは、Ceph ユーザーまたは Ceph クライアントに付与できる、ブロックデバイス、オブジェクトストレージ、ファイルシステム、ネイティブ API などのさまざまなアクセス機能またはエンティティー機能を説明します。

さらに、クライアントにロールを割り当てるときに機能プロファイルを記述することができます。

allow, 説明-

これは、デーモンのアクセス設定の前に使用します。MDS のみの

rwを意味します r, 説明- ユーザーに 読み取り 権限を付与します。CRUSH マップを取得するためにモニターで必要です。

w, 説明- ユーザーにオブジェクトへの 書き込み 権限を付与します。

x, 説明-

クラスメソッド (読み取り および 書き込み の両方) をユーザーに呼び出し、モニターで

auth操作を実行する機能を提供します。 class-read, 説明-

クラスの読み取りメソッドを呼び出すケイパビリティーをユーザーに提供します。

xのサブセット。 class-write, 説明-

クラスの書き込みメソッドを呼び出すケイパビリティーをユーザーに提供します。

xのサブセット。 - *,

all, 説明 - ユーザーに、特定のデーモンまたはプールに対する 読み取り、書き込み、実行 権限と、管理コマンドを実行する権限を与えます。

次のエントリーは、有効な機能プロファイルを説明します。

profile osd, 説明- これは Ceph Monitor にのみ適用されます。OSD として他の OSD またはモニターに接続するためのパーミッションをユーザーに付与します。OSD がレプリケーションのハートビートトラフィックおよびステータス報告を処理できるようにするために OSD に付与されました。

profile mds, 説明- これは Ceph Monitor にのみ適用されます。MDS として他の MDS またはモニターに接続する権限をユーザーに与えます。

profile bootstrap-osd, 説明-

これは Ceph Monitor にのみ適用されます。OSD をブートストラップする権限をユーザーに与えます。

ceph-volumeやcephadmなどのデプロイメントツールに付与され、OSD のブートストラップ時にキーを追加する権限が与えられます。 profile bootstrap-mds, 説明-

これは Ceph Monitor にのみ適用されます。メタデータサーバーをブートストラップする権限をユーザーに与えます。

cephadmなどのデプロイメントツールに付与され、メタデータサーバーのブートストラップ時にキーを追加する権限が与えられます。 profile bootstrap-rbd, 説明-

これは Ceph Monitor にのみ適用されます。RBD ユーザーをブートストラップする権限をユーザーに与えます。

cephadmなどのデプロイメントツールに付与され、RBD ユーザーをブートストラップするときにキーを追加する権限が与えられます。 profile bootstrap-rbd-mirror, 説明-

これは Ceph Monitor にのみ適用されます。

rbd-mirrorデーモンユーザーをブートストラップする権限をユーザーに与えます。cephadmなどのデプロイメントツールに付与され、rbd-mirrorデーモンのブートストラップ時にキーを追加する権限が与えられます。 profile rbd, 説明-

これは、Ceph Monitor、Ceph Manager、および Ceph OSD に適用されます。RBD イメージを操作する権限をユーザーに与えます。モニターキャップとして使用すると、RBD クライアントアプリケーションに必要な最小限の権限がユーザーに提供されます。このような権限には、他のクライアントユーザーをブロックリストに登録する機能が含まれます。OSD キャップとして使用すると、RBD クライアントアプリケーションに指定されたプールへの読み取り/書き込みアクセスが提供されます。Manager のキャップは、オプションの

poolおよびnamespaceキーワード引数をサポートします。 profile rbd-mirror, 説明-

これは Ceph Monitor にのみ適用されます。RBD イメージを操作し、RBD ミラーリング設定キーのシークレットを取得する権限をユーザーに与えます。ユーザーが

rbd-mirrorデーモンを操作するために必要な最小限の権限を提供します。 profile rbd-read-only, 説明-

これは Ceph Monitor と Ceph OSDS に適用されます。ユーザーに RBD イメージに対する読み取り専用権限を与えます。Manager のキャップは、オプションの

poolおよびnamespaceキーワード引数をサポートします。 profile simple-rados-client, 説明- これは Ceph Monitor にのみ適用されます。ユーザーにモニター、OSD、PG データに対する読み取り専用権限を与えます。直接の librados クライアントアプリケーションによる使用を目的としています。

profile simple-rados-client-with-blocklist, 説明- これは Ceph Monitor にのみ適用されます。ユーザーにモニター、OSD、PG データに対する読み取り専用権限を与えます。直接の librados クライアントアプリケーションによる使用を目的としています。高可用性 (HA) アプリケーションを構築するためにブロックリストエントリーを追加する権限も含まれます。

profile fs-client, 説明- これは Ceph Monitor にのみ適用されます。ユーザーにモニター、OSD、PG、および MDS データに対する読み取り専用権限を与えます。CephFS クライアントを対象としています。

profile role-definer, 説明- これは Ceph Monitor と Auth に適用されます。ユーザーに、認証サブシステムに対する すべて の権限、モニターへの読み取り専用アクセス権を与えますが、それ以外は何も与えません。自動化ツールに役立ちます。警告: セキュリティーへの影響は重大かつ広範囲に及ぶため、実際に何をしているのかを理解していない限り、これを割り当てないでください。

profile crash, 説明-

これは Ceph Monitor と Ceph Manager に適用されます。ユーザーにモニターへの読み取り専用アクセスを与えます。後で分析するためにデーモン

crashダンプをモニターストレージにアップロードするために、マネージャークラッシュモジュールと組み合わせて使用されます。

4.6. ユーザー機能の作成

Ceph Dashboard で、さまざまな機能を持つロールベースのアクセスユーザーを作成します。

さまざまなユーザー権限の詳細は、ユーザー権限 および アクセス権限 を参照してください。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ダッシュボードへの管理者レベルのアクセス権。

手順

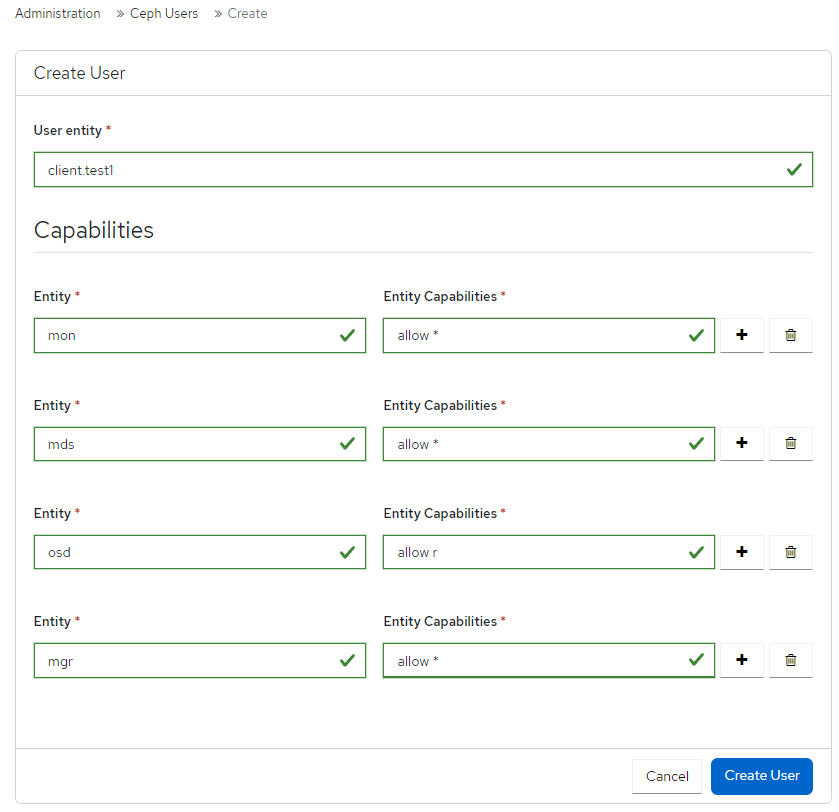

- ダッシュボードのナビゲーションから、Administration→Ceph Users に移動します。

- Create をクリックします。

Create User フォームで、次の詳細を入力します。

-

User entity:

TYPE.IDを入力します。 -

Entity:

mon、mgr、osd、mdsのいずれかです。 Entity Capabilities: ユーザーに提供できる機能を入力します。たとえば、'allow *' と

profile crashは、クライアントに割り当てることができる機能の一部です。注記要件に基づき、さらにエンティティーをユーザーに追加できます。

-

User entity:

Create User をクリックします。

ユーザーが正常に作成されたことを示す通知が表示されます。

4.7. ユーザー機能の編集

ダッシュボードでユーザーまたはクライアントのロールを編集します。

さまざまなユーザー権限の詳細は、ユーザー権限 および アクセス権限 を参照してください。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ダッシュボードへの管理者レベルのアクセス権。

手順

- ダッシュボードのナビゲーションから、Administration→Ceph Users に移動します。

- ロールを編集するユーザーを選択します。

- Edit をクリックします。

Edit User フォームで、必要に応じて Entity と Entity Capabilities を編集します。

注記要件に基づいて、さらにエンティティーをユーザーに追加できます。

Edit User をクリックします。

ユーザーが正常に編集されたことを示す通知が表示されます。

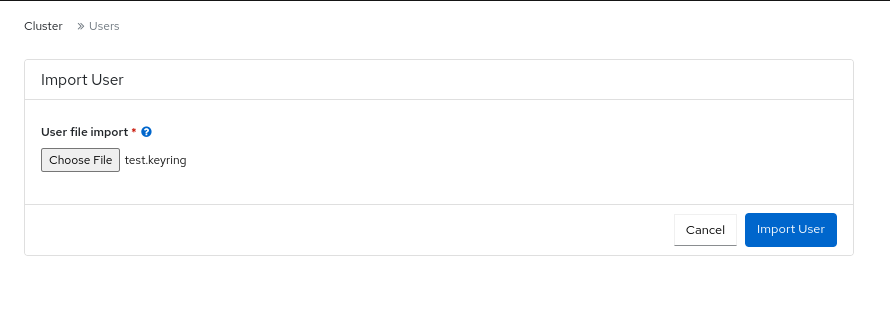

4.8. ユーザー機能のインポート

ユーザーまたはクライアントのロールをローカルホストからダッシュボード上のクライアントにインポートします。

さまざまなユーザー権限の詳細は、ユーザー権限 および アクセス権限 を参照してください。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ダッシュボードへの管理者レベルのアクセス権。

手順

ローカルホスト上にキーリングファイルを作成します。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - ダッシュボードのナビゲーションから、Administration→Ceph Users に移動します。

- ロールをエクスポートするユーザーを選択します。

- Edit→Import を選択します。

- Import User フォームで、Choose File をクリックします。

- ローカルホスト上のファイルを参照して選択します。

Import User をクリックします

キーが正常にインポートされたことを示す通知が表示されます。

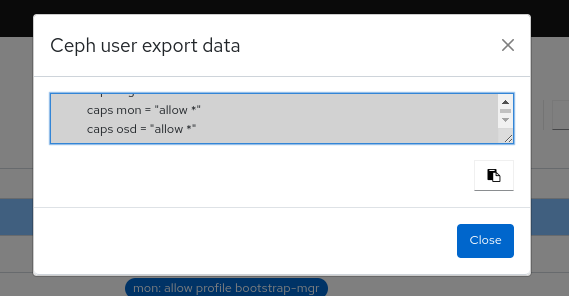

4.9. ユーザー機能のエクスポート

ユーザーまたはクライアントのロールをダッシュボードからローカルホストにエクスポートします。

さまざまなユーザー権限の詳細は、ユーザー権限 および アクセス権限 を参照してください。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ダッシュボードへの管理者レベルのアクセス権。

手順

- ダッシュボードのナビゲーションから、Administration→Ceph Users に移動します。

- ロールをエクスポートするユーザーを選択します。

- アクションドロップダウンから Export を選択します。

Ceph user export data ダイアログから、Copy to Clipboard をクリックします。

キーが正常にコピーされたことを示す通知が表示されます。

ローカルシステムでキーリングファイルを作成し、キーを貼り付けます。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Close をクリックします。

4.10. ユーザー機能の削除

ダッシュボード上のユーザーまたはクライアントのロールを削除します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ダッシュボードへの管理者レベルのアクセス権。

手順

- ダッシュボードのナビゲーションから、Administration→Ceph Users に移動します。

- 削除するユーザーを選択し、アクションドロップダウンから Delete を選択します。

- Delete user ダイアログで、Yes, I am sure を選択します。

Delete user をクリックします。

ユーザーが正常に削除されたことを示す通知が表示されます。

第5章 Ceph デーモンの管理

ストレージ管理者は、Red Hat Ceph Storage Dashboard で Ceph デーモンを管理できます。

5.1. デーモンアクション

Red Hat Ceph Storage Dashboard を使用すると、デーモンを開始、停止、再起動、および再デプロイできます。

これらのアクションは、Monitor Daemon と Manager Daemon を除くすべてのデーモンでサポートされています。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ストレージクラスターに少なくとも 1 つのデーモンが設定されている。

手順

デーモンは 2 つの方法で管理できます。

サービスページから:

- ダッシュボードのナビゲーションから、Administration→Services に移動します。

アクションを実行するデーモンでサービスを展開します。

注記この行は、いつでも折りたたむことができます。

Daemons タブで、デーモンの行を選択します。

注記Daemons テーブルは検索およびフィルタリングできます。

デーモンで実行する必要があるアクションを選択します。オプションは、Start、Stop、Restart、Redeploy です。

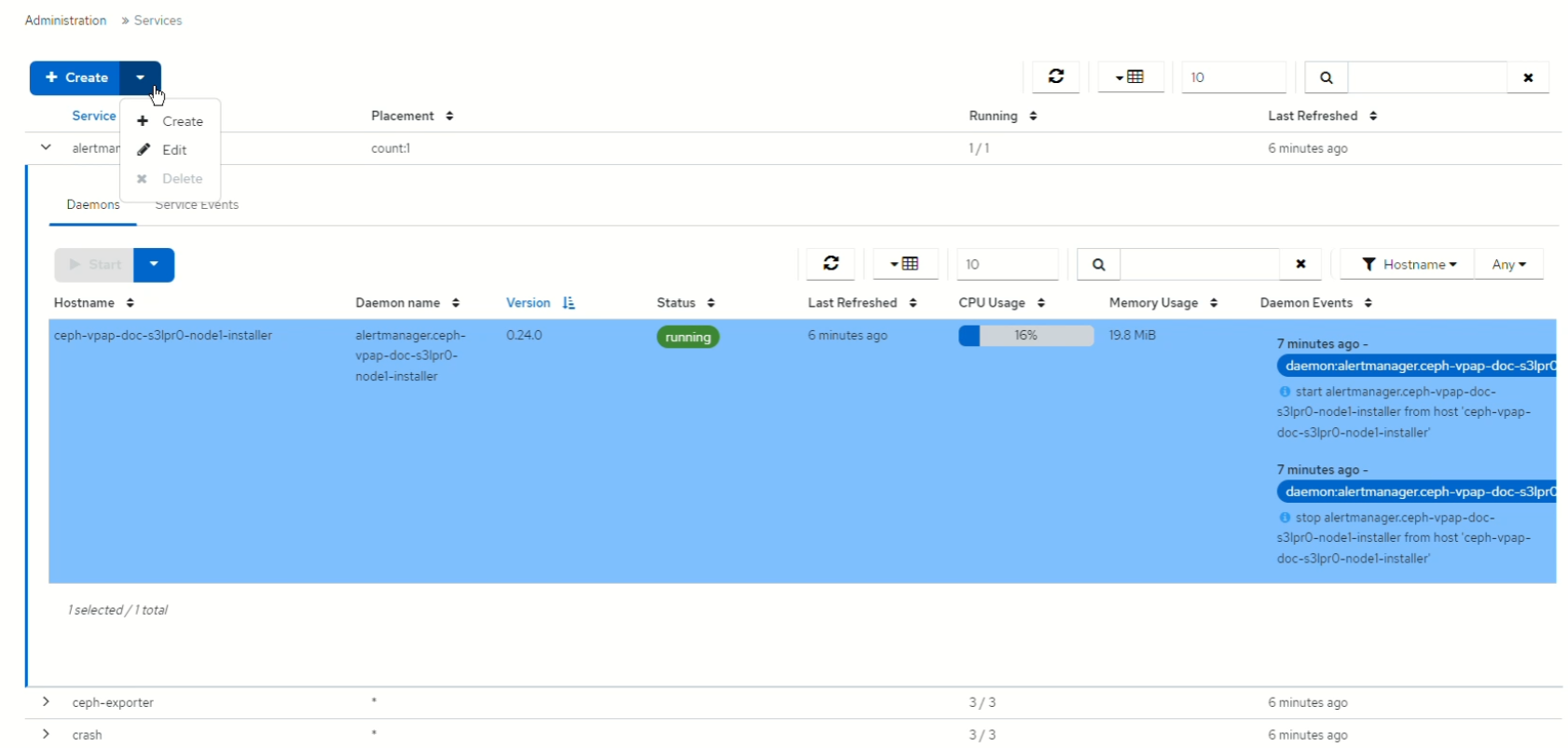

図5.1 サービスからデーモンを管理する

ホストページから:

- ダッシュボードのナビゲーションから、Cluster→Hosts に移動します。

- Hosts List タブでホスト行を展開し、アクションを実行するデーモンがあるホストを選択します。

ホストの Daemons タブで、デーモンの行を選択します。

注記Daemons テーブルは検索およびフィルタリングできます。

デーモンで実行する必要があるアクションを選択します。オプションは、Start、Stop、Restart、Redeploy です。

図5.2 ホストからデーモンを管理する

第6章 Ceph Dashboard でのクラスターの監視

ストレージ管理者は、Red Hat Ceph Storage Dashboard を使用して、ホストのタイプ、サービス、データアクセス方法などに基づいて、クラスターの特定の側面を監視できます。

このセクションでは、以下の管理タスクを説明します。

- ダッシュボードでの Ceph クラスターのホストの監視

- ダッシュボードでの Ceph クラスター設定の表示および編集

- ダッシュボードでの Ceph クラスターのマネージャーモジュールの表示および編集

- ダッシュボードでの Ceph クラスターのモニターの監視

- ダッシュボードでの Ceph クラスターのモニタリングサービス

- ダッシュボードでの Ceph OSD の監視

- ダッシュボードでの HAProxy の監視

- ダッシュボードでの Ceph クラスターの CRUSH マップの表示

- ダッシュボードでの Ceph クラスターログのフィルタリング

- ダッシュボードでの Ceph クラスターの集中ログの表示

- ダッシュボードでの Ceph クラスターのプールの監視

- ダッシュボードでの Ceph ファイルシステムの監視

- ダッシュボードでの Ceph Object Gateway デーモンの監視

- Ceph Dashboard でのブロックデバイスイメージの監視

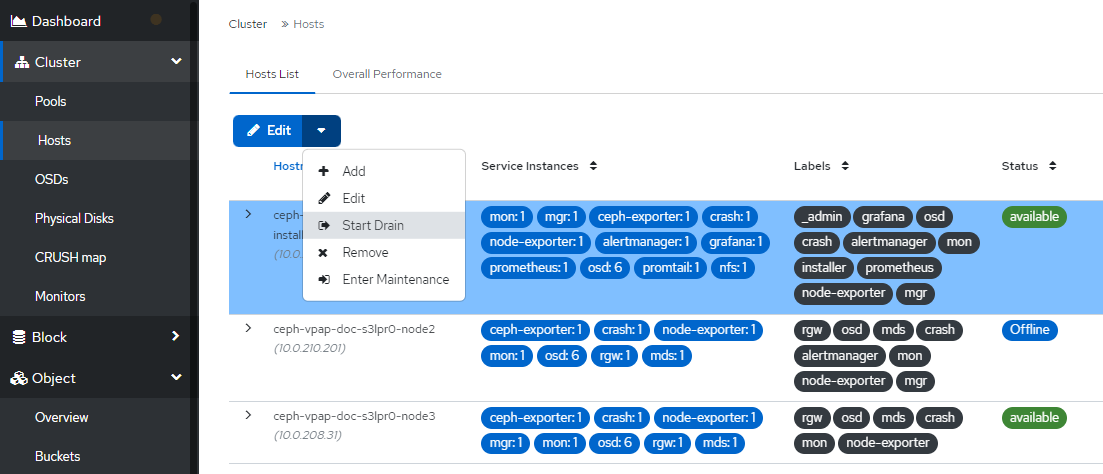

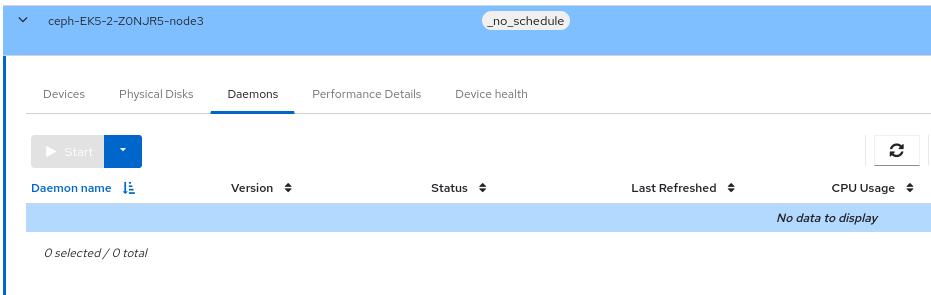

6.1. ダッシュボードでの Ceph クラスターのホストの監視

Red Hat Ceph Storage Dashboard でクラスターのホストを監視できます。

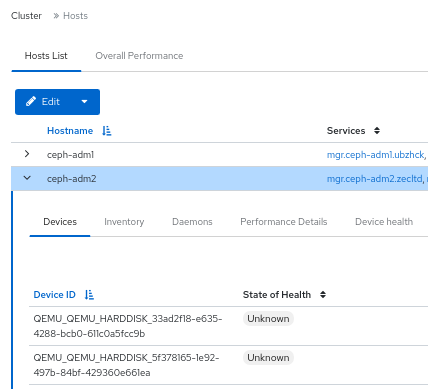

以下で、ホストページの各種タブを説明します。各タブには、関連情報を含むテーブルが含まれています。テーブルは列と行で検索およびカスタマイズできます。

列の順序を変更するには、列名を選択し、テーブル内でドラッグして配置します。

表示する列を選択するには、toggle columns ボタンをクリックして、列名を選択またはクリアします。

行セレクターフィールドに表示する行数を入力します。

- Devices

- このタブには、デバイス ID、デバイスヘルスの状態、平均存続期間、デバイス名、予測作成日、ホスト上のデーモンの詳細を示すテーブルがあります。

- Physical Disks

- このタブには、選択したホストに接続されているすべてのディスク、およびそのタイプやサイズなどの詳細を示すテーブルがあります。デバイスパス、デバイスのタイプ、可用性、ベンダー、モデル、サイズ、デプロイされた OSD などの詳細があります。どのディスクが物理デバイス上のどこにあるかを識別するには、デバイスを選択し、Identify をクリックします。選択したディスクを見つけられるように、LED を点滅させる時間を選択します。

- Daemons

- このタブには、選択したホストにデプロイされたすべてのサービス、実行中のコンテナー、および現在のステータスの詳細を示すテーブルがあります。テーブルには、デーモン名、デーモンのバージョン、ステータス、デーモンの最終更新日時、CPU 使用率、メモリー使用量 (MiB 単位)、デーモンイベントなどの詳細が表示されます。このタブからデーモンアクションを実行できます。詳細は、デーモンアクション を参照してください。

- パフォーマンスの詳細

- このタブには、デプロイされた OSD、CPU 使用率、RAM 使用率、ネットワーク負荷、ネットワークドロップ率、OSD ディスクのパフォーマンス統計などの詳細が表示されます。組み込まれた Grafana ダッシュボードを通じてパフォーマンス情報を表示します。

- デバイスの正常性

- スマート対応デバイスの場合には、OSD がデプロイされたホスト上でのみ個々のヘルスステータスと SMART データを取得できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ホストがストレージクラスターに追加されている。

- すべてのサービス、モニター、マネージャー、および OSD デーモンがストレージクラスターにデプロイされている。

手順

- ダッシュボードのナビゲーションから、Cluster→Hosts に移動します。

- Hosts List タブでホスト行を展開し、アクションを実行するデーモンがあるホストを選択します。

ホストの Daemons タブで、デーモンの行を選択します。

注記Daemons テーブルは検索およびフィルタリングできます。

デーモンで実行する必要があるアクションを選択します。オプションは、Start、Stop、Restart、Redeploy です。

図6.1 Ceph クラスターのホストの監視

6.2. ダッシュボードでの Ceph クラスターの設定の表示と編集

ダッシュボードで Ceph クラスターのさまざまな設定オプションを表示できます。編集できるのは一部の設定オプションのみです。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- すべてのサービスがストレージクラスターにデプロイされている。

手順

- ダッシュボードのナビゲーションから、Administration→Configuration に移動します。

設定の詳細を表示するには、行の内容を展開します。

図6.2 設定オプション

- オプション: 検索フィールドを使用して設定を検索します。

オプション: 特定の設定をフィルタリングできます。次のフィルターを使用します。

- Level - Basic、advanced または dev

- Service - Any、mon、mgr、osd、mds、common、mds_client、rgw などのフィルター。

- Source - Any、mon などのフィルター

- Modified - Yes または No

設定を編集するには、設定行を選択し、Edit をクリックします。

Edit フォームを使用して必要なパラメーターを編集し、Update をクリックします。

設定が正常に更新されたことを示す通知が表示されます。

6.3. ダッシュボードでの Ceph クラスターのマネージャーモジュールの表示および編集

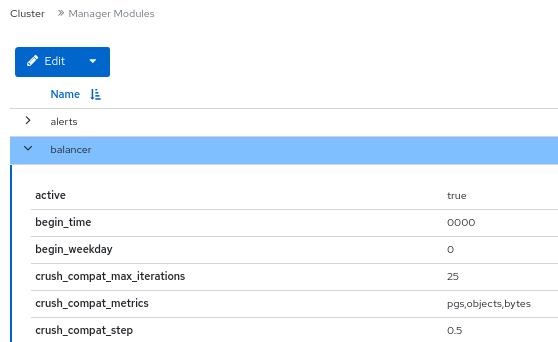

マネージャーモジュールは、モジュール固有の設定管理すに使用されます。たとえば、クラスターのヘルスに関するアラートを有効にできます。

Red Hat Ceph Storage Dashboard で、クラスターのマネージャーモジュールを表示、有効化、無効化、および編集できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

マネージャーモジュールの表示

- ダッシュボードのナビゲーションから、Administration→Manager Modules に移動します。

特定のマネージャーモジュールの詳細を表示するには、行の内容を展開します。

図6.3 マネージャーモジュール

マネージャーモジュールの有効化

行を選択し、アクションドロップダウンから Enable をクリックします。

マネージャーモジュールの無効化

行を選択し、アクションドロップダウンから Disable をクリックします。

マネージャーモジュールの編集

行を選択します。

注記すべてのモジュールに設定可能なパラメーターがあるわけではありません。モジュールが設定できない場合、Edit ボタンは無効になります。

必要なパラメーターを編集し、Update をクリックします。

モジュールが正常に更新されたことを示す通知が表示されます。

6.4. ダッシュボードでの Ceph クラスターのモニター監視

Ceph モニターのパフォーマンスを監視するには、Red Hat Ceph Storage ダッシュボードのランディングページで、モニターのステータス、クォーラム、オープンセッション数、パフォーマンスカウンターなどの詳細を Monitors パネルに表示することもできます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- モニターはストレージクラスターにデプロイされます。

手順

ダッシュボードのナビゲーションから、Cluster→Monitors に移動します。

Monitors パネルには、全体的なモニターのステータスと、クォーラム内およびクォーラム外にあるモニターホストに関する情報が表示されます。

開いているセッションの数を確認するには、Open Sessions の上にカーソルを置きます。

任意のモニターのパフォーマンスカウンターを表示するには、In Quorum テーブルと Not In Quorum テーブルで Name をクリックします。

図6.4 モニターのパフォーマンスカウンターの表示

6.5. ダッシュボードでの Ceph クラスターの監視サービス

Red Hat Ceph Storage Dashboard でクラスターのサービスを監視できます。ホスト名、デーモンタイプ、デーモン ID、コンテナー ID、コンテナーイメージ名、コンテナーイメージ ID、バージョンステータス、最終更新時刻の詳細を表示できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ホストがストレージクラスターに追加されている。

- すべてのサービスがストレージクラスターにデプロイされている。

手順

- ダッシュボードのナビゲーションから、Administration→Services に移動します。

サービスを展開して詳細を確認します。

図6.5 Ceph クラスターの監視サービス

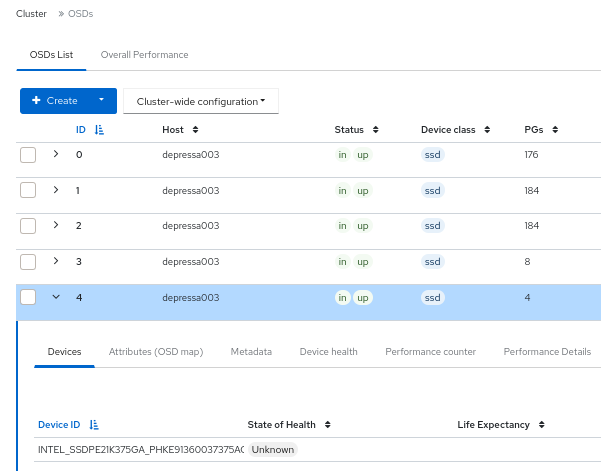

6.6. ダッシュボードでの Ceph OSD の監視

Red Hat Ceph Storage Dashboard のランディングページで、Ceph OSD のステータスを監視できます。OSD タブでは、ホスト、ステータス、デバイスクラス、プレイスメントグループ (PG) の数、サイズフラグ、使用状況、読み取りまたは書き込み操作時間などの詳細を表示することもできます。

OSD ページのさまざまなタブを次に示します。

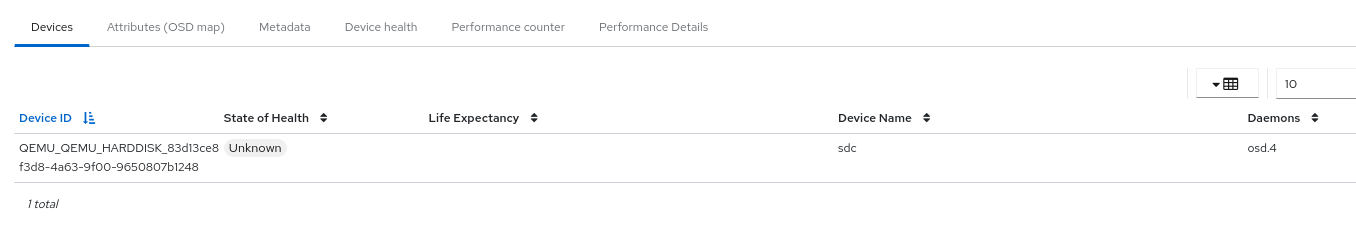

- デバイス - このタブには、デバイス ID、ヘルス状態、有効期限、デバイス名、ホストのデーモンなどの詳細が表示されます。

- 属性 (OSD マップ) - このタブには、クラスターアドレス、ハートビートの詳細、OSD の状態、およびその他の OSD 属性が表示されます。

- メタデータ - このタブには、OSD オブジェクトストア、デバイス、オペレーティングシステム、およびカーネルの詳細が表示されます。

- デバイスのヘルス - スマート対応デバイスの場合には、個々のヘルスステータスと SMART データを取得できます。

- パフォーマンスカウンター - このタブには、デバイスに書き込まれたバイトの詳細が表示されます。

- パフォーマンスの詳細 - このタブには、デプロイされた OSD、CPU 使用率、RAM 使用率、ネットワーク負荷、ネットワークドロップ率、OSD ディスクのパフォーマンス統計などの詳細が表示されます。組み込まれた Grafana ダッシュボードを通じてパフォーマンス情報を表示します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ホストがストレージクラスターに追加されている。

- OSD を含むすべてのサービスがストレージクラスターにデプロイされている。

手順

- ダッシュボードのナビゲーションから、Cluster→OSDs に移動します。

特定の OSD の詳細を表示するには、OSDs List タブで OSD 行を展開します。

図6.6 Ceph クラスターの OSD のモニタリング

各タブをクリックすると、Devices、Attributes (OSD map)、Metadata、Device Health、Performance counter、Performance Details などの詳細を表示できます。

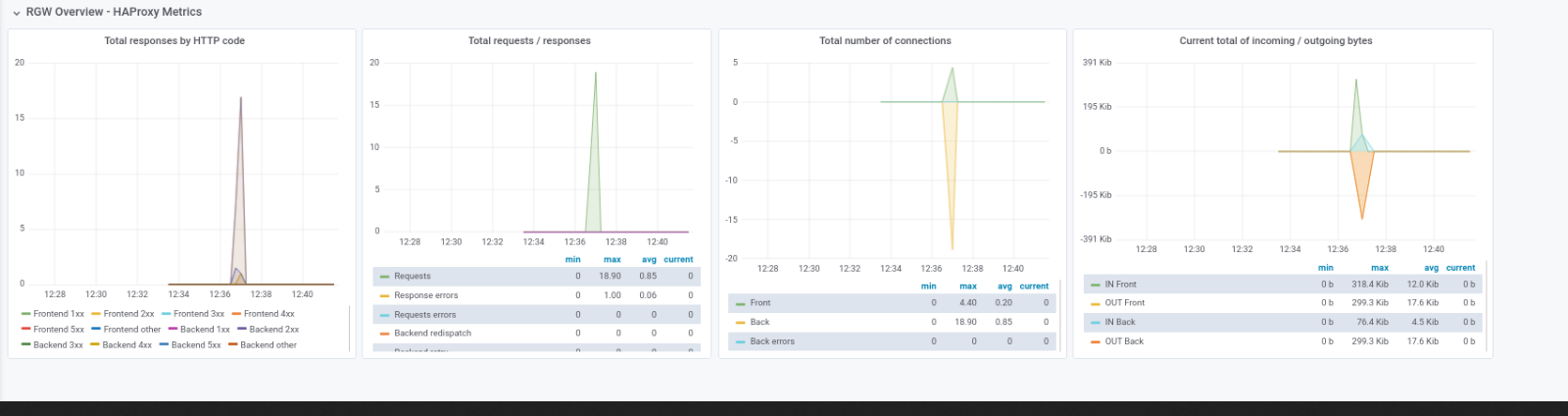

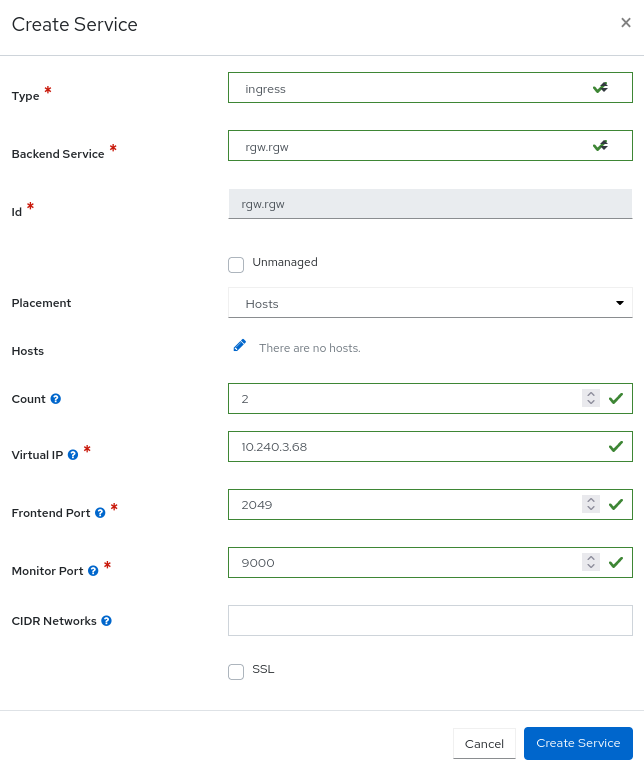

6.7. ダッシュボードでの HAProxy の監視

Ceph Object Gateway を使用すると、オブジェクトゲートウェイの多くのインスタンスを 1 つのゾーンに割り当てできるため、負荷の増加に合わせてスケールアウトすることができます。各オブジェクトゲートウェイインスタンスは独自の IP アドレスを持つため、HAProxy を使用して Ceph Object Gateway サーバー全体で負荷を分散できます。

ダッシュボードで次の HAProxy メトリックを監視できます。

- HTTP コードごとの合計応答数。

- 要求/応答の合計数。

- 接続の合計数。

- 着信/発信バイトの現在の合計数。

ceph dashboard get-grafana-api-url コマンドを実行して、Grafana の詳細を取得することもできます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ストレージダッシュボードでの管理者レベルのアクセスがある。

- SSL を使用しない既存の Ceph Object Gateway サービスがある。SSL サービスが必要な場合は、Ceph Object Gateway サービスではなく、Ingress サービスで証明書を設定する必要があります。

- Ceph Orchestrator を使用してデプロイされた Ingress サービスがある。

- モニタリングスタックコンポーネントがダッシュボード上に作成されている。

手順

Grafana URL にログインし、RGW_Overview パネルを選択します。

構文

https://DASHBOARD_URL:3000

https://DASHBOARD_URL:3000Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

https://dashboard_url:3000

https://dashboard_url:3000Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Grafana URL で HAProxy メトリックを確認します。

- Ceph ダッシュボードのナビゲーションから、Object → Gateways に移動します。

Overall Performance タブから、Ceph Object Gateway HAProxy メトリクスを確認します。

図6.7 HAProxy メトリック

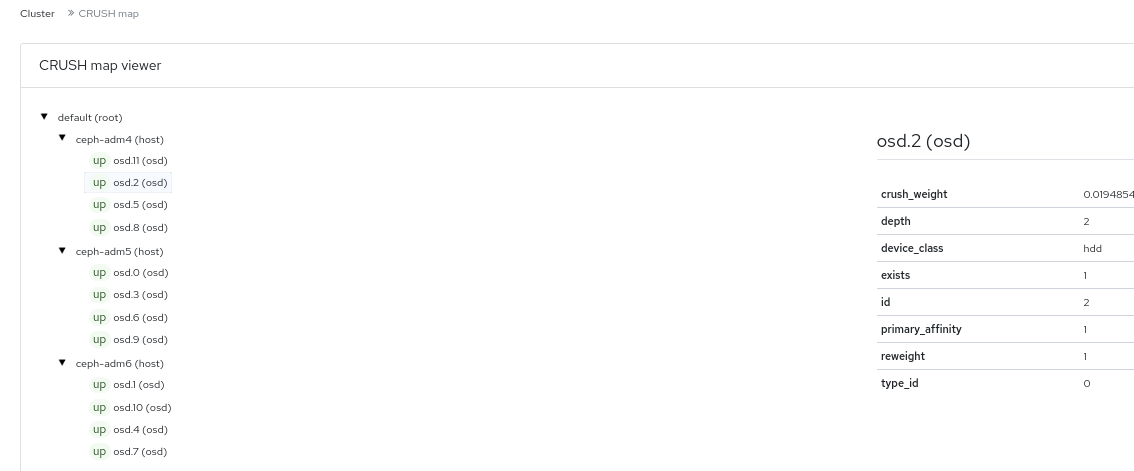

6.8. ダッシュボードでの Ceph クラスターの CRUSH マップの表示

Red Hat Ceph Storage Dashboard で、OSD のリストおよび関連情報を含む CRUSH マップを表示できます。CRUSH マップおよび CRUSH アルゴリズムが一緒になって、データの保存方法と場所を決めます。このダッシュボードでは、OSD ホスト、OSD デーモン、ID 番号、デバイスクラスなど、CRUSH マップのさまざまな側面を確認することができます。

CRUSH マップを使用すると、特定の OSD ID が実行しているホストを決定できます。これは、OSD に問題がある場合に便利です。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- OSD デーモンがストレージクラスターにデプロイされている。

手順

- ダッシュボードのナビゲーションから、Cluster→CRUSH map に移動します。

特定の OSD の詳細を表示するには、その行をクリックします。

図6.8 CRUSH Map の詳細ビュー

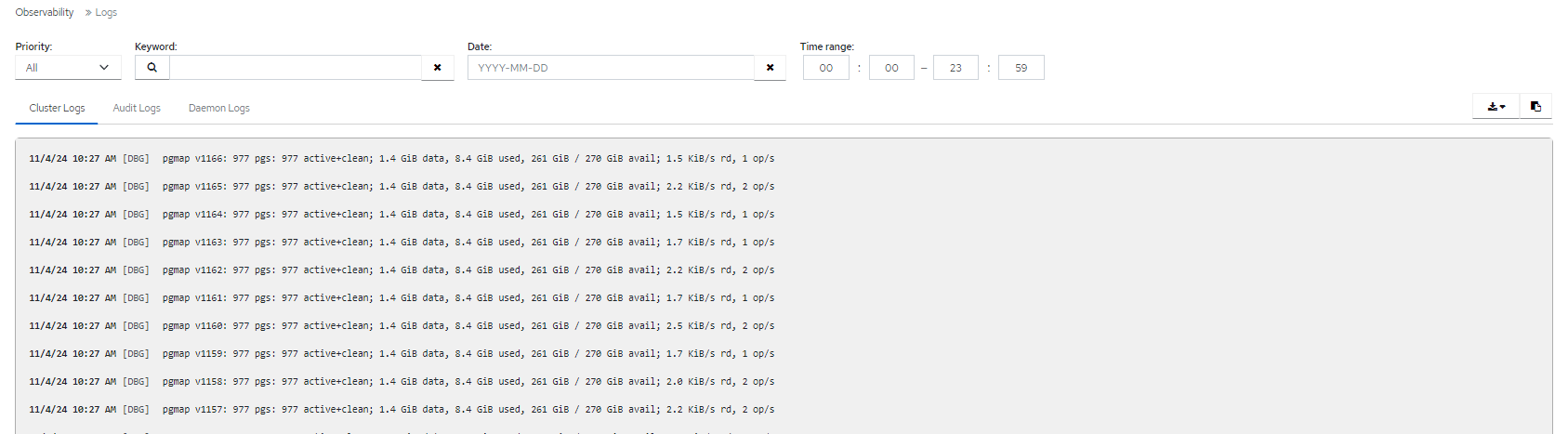

6.9. ダッシュボードでの Ceph クラスターのログのフィルタリング

いくつかの条件をもとに、ダッシュボードで Red Hat Ceph Storage クラスターのログを表示およびフィルタリングできます。条件には、優先度、キーワード、日付、および 時間範囲 が含まれます。

ログをシステムにダウンロードするか、ログをクリップボードにコピーして、さらに分析することができます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- Ceph Monitor が最後に起動されてからログエントリーが生成されている。

Dashboard ロギング機能は最新の高レベルイベントのみを表示します。イベントは Ceph Monitor によってメモリーに格納されます。Monitor を再起動すると、エントリーが消えます。詳細なログまたは古いログを確認する必要がある場合は、ファイルベースのログを参照してください。

手順

- ダッシュボードのナビゲーションから、Observability→Logs に移動します。

Cluster Logs タブから、クラスターログを表示します。

図6.9 クラスターログ

- Priority フィルターを使用して、Debug、Info、Warning、Error、またはAll でフィルタリングします。

- キーワードで検索するためのテキストを入力するには、Keyword フィールドを使用します。

- 特定の日付でフィルタリングするには、Date ピッカーを使用します。

-

Time range フィールドを使用して、HH:MM - HH:MM 形式で範囲を入力します。時間は、数字

0から23に入力する必要があります。 - フィルターを組み合わせるには、2 つ以上のフィルターを設定します。

- ログを保存するには、Download または Copy to Clipboard ボタンを使用します。

6.10. ダッシュボードでの Ceph クラスターの集中ログの表示

Ceph Dashboard を使用すると、Red Hat Ceph Storage クラスター内の集中スペースですべてのクライアントからのログを表示でき、効率的に監視できます。これは、ログの保存とクエリー用に設計されたログ集約システムである Loki と、ローカルログの内容をプライベート Grafana Loki インスタンスに送信するエージェントである Promtail を使用することで実現されます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- Grafana が設定され、クラスターにログインしている。

手順

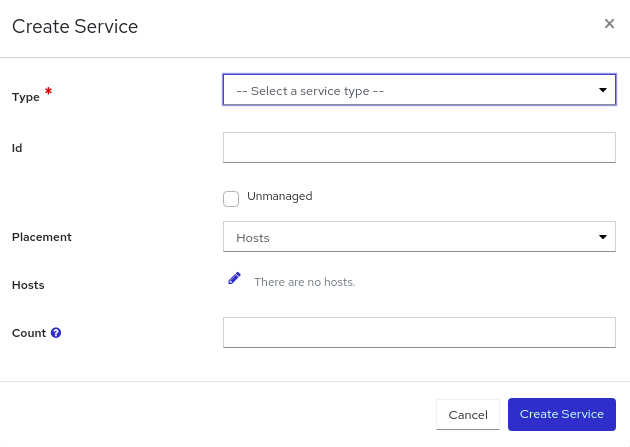

- ダッシュボードのナビゲーションから、Administration→Services に移動します。

- Services から Create をクリックします。

-

Create Service フォームの Type リストから、

Lokiを選択します。残りの詳細を入力し、Create Service をクリックします。 前の手順を繰り返して、

Promtailサービスを作成します。Type リストからpromtailを選択します。lokiおよびpromtailサービスが正常に作成されると、Services テーブルに表示されます。図6.10 Loki および Promtail サービスの作成

注記

注記デフォルトでは、Promtail サービスは実行中のすべてのホストにデプロイされます。

ファイルへのログ記録を有効にします。

- Administration→Configuration に移動します。

-

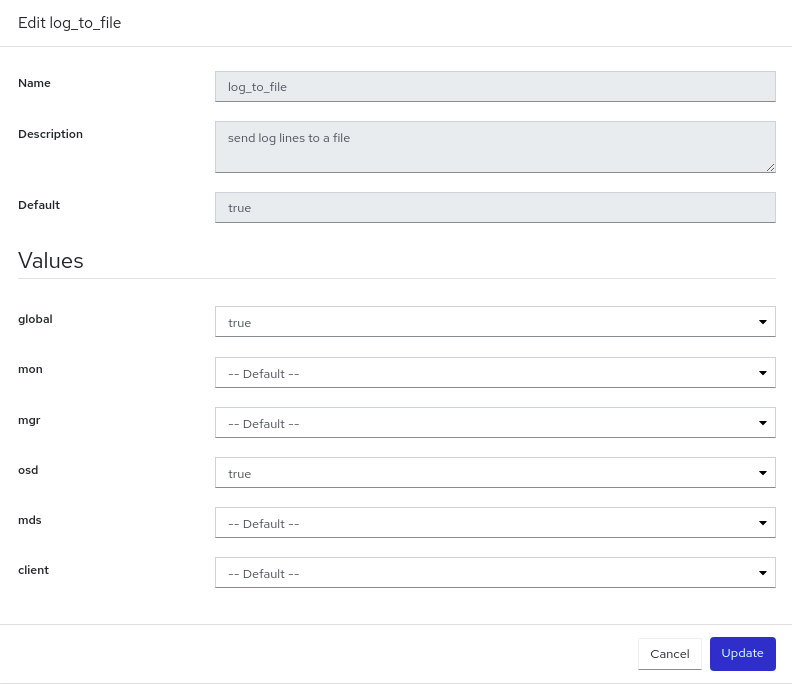

log_to_fileを選択し、Edit をクリックします。 Edit log_to_file フォームで、global 値を

trueに設定します。図6.11 ログファイルの設定

Update をクリックします。

Updated config option log_to_file通知が表示され、Configuration テーブルに戻ります。mon_cluster_log_to_fileに対してこれらの手順を繰り返し、global 値をtrueに設定します。注記log_to_fileファイルとmon_cluster_log_to_fileファイルの両方を設定する必要があります。

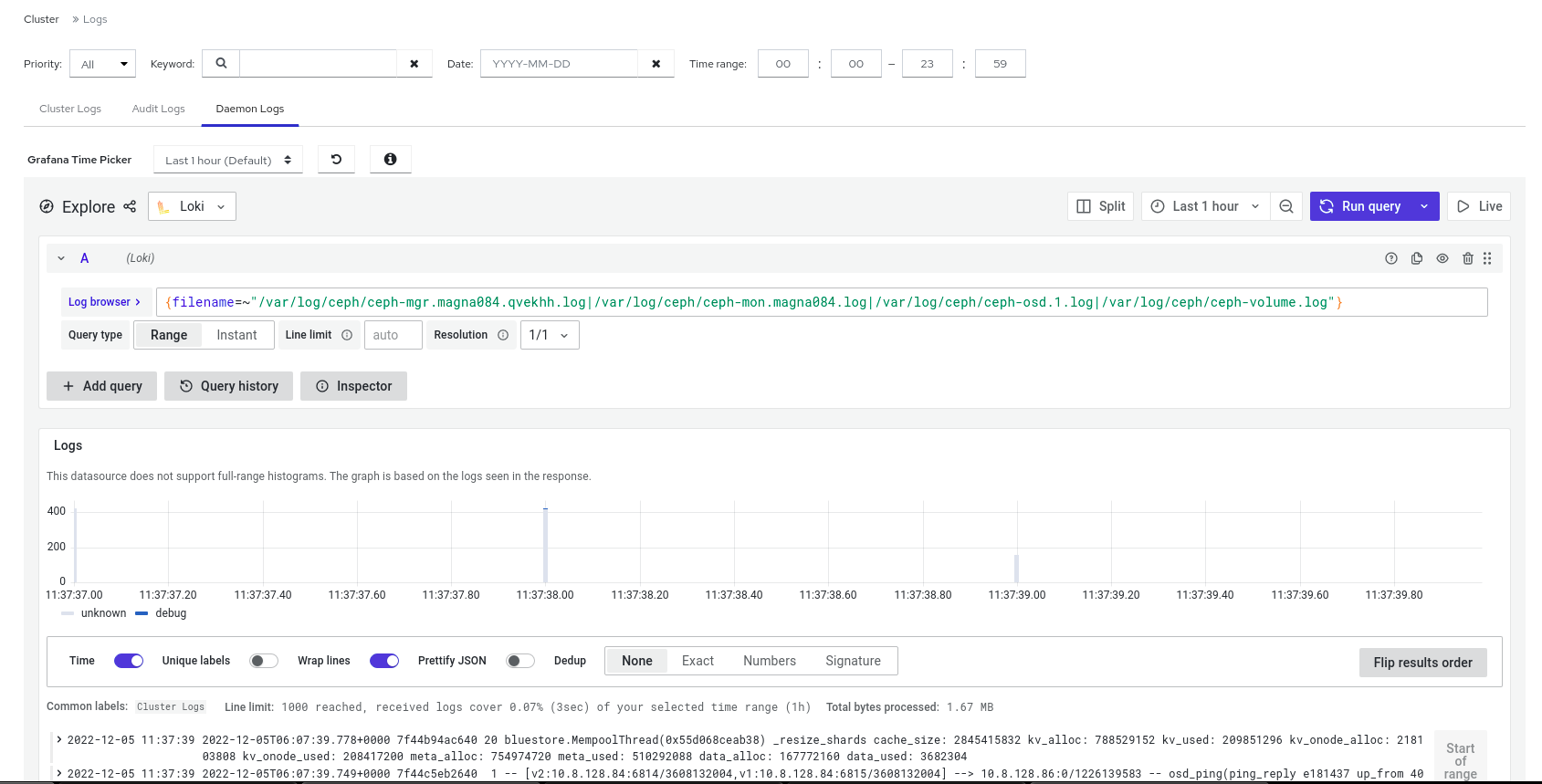

集約ログを表示します。

Observability→Logs に移動し、Daemon Logs タブに切り替えます。Log browser 使用してファイルを選択し、Show logs をクリックしてそのファイルのログを表示します。

図6.12 集中ログの表示

注記

注記ログが表示されない場合は、Grafana にサインインしてページをリロードする必要があります。

6.11. ダッシュボードでの Ceph クラスターのプールの監視

Red Hat Ceph Storage Dashboard では、クラスター内のプールの詳細、パフォーマンスの詳細、設定、および全体的なパフォーマンスを表示できます。

プールは、Ceph Storage クラスターがデータを分散し、格納する方法において重要なロールを果たします。プールを作成せずにクラスターをデプロイした場合に、Ceph はデフォルトのプールを使用してデータを格納します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- プールが作成されている。

手順

- ダッシュボードのナビゲーションから、Cluster→Pools に移動します。

- Pools List タブを表示します。ここには、データ保護の詳細と、プールが有効になっているアプリケーションが表示されます。必要な詳細を表示するには、Usage、Read bytes、Write bytes にマウスを置きます。

特定のプールの詳細情報を表示するには、プールの行を展開します。

図6.13 プールの監視

- 一般的な情報は、Overall Performance タブに移動してください。

6.12. ダッシュボードでの Ceph ファイルシステムの監視

Red Hat Ceph Storage Dashboard を使用して Ceph File Systems (CephFS) および関連するコンポーネントを監視することができます。

リストされているファイルシステムごとに、次のタブが使用できます。

- Details

- メタデータサーバー (MDS) とそのランクに加えて、スタンバイデーモン、プール、その使用状況、パフォーマンスカウンターを表示します。

- Directories

- ディレクトリー、そのクォータおよびスナップショットのリストを表示します。ディレクトリーを選択して、最大ファイルおよびサイズクォータの設定や設定解除、および特定ディレクトリーのスナップショットの作成や削除を行います。

- Subvolumes

- サブボリューム情報を作成、編集、表示します。これらはサブボリュームグループによってフィルタリングできます。

- Subvolume groups

- サブボリュームグループ情報を作成、編集、表示します。

- スナップショット

- スナップショット情報を作成、複製、表示します。これらはサブボリュームグループとサブボリュームでフィルタリングできます。

- Snapshot schedules

- スナップショットスケジュールを有効化、作成、編集、削除します。

- Clients

- Ceph ファイルシステムのクライアント情報を表示および削除します。

- Performance Details

- 組み込みの Grafana ダッシュボードを通じて、ファイルシステムのパフォーマンスを表示します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- MDS サービスが少なくとも 1 つのホストにデプロイされている。

- Ceph File System がインストールされている。

手順

- ダッシュボードのナビゲーションから、File→File Systems に移動します。

- 個々のファイルシステムに関する詳細情報を表示するには、ファイルシステムの行を展開します。

6.13. ダッシュボードでの Ceph Object Gateway デーモンの監視

Red Hat Ceph Storage Dashboard を使用して、Ceph Object Gateway デーモンを監視できます。Ceph Object Gateway デーモンの詳細、パフォーマンスカウンター、およびパフォーマンスの詳細を表示できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- ストレージクラスターに少なくとも 1 つの Ceph Object Gateway デーモンが設定されている。

手順

- ダッシュボードのナビゲーションから、Object→Gateways に移動します。

- Gateways List タブから、個々のゲートウェイに関する情報を表示します。

- 個々のゲートウェイの詳細情報を表示するには、ゲートウェイの行を展開します。

- Ceph Object Gateway を複数設定している場合は、Sync Performance タブをクリックして、マルチサイトのパフォーマンスカウンターを表示します。

6.14. Ceph ダッシュボードでのブロックデバイスイメージの監視

Red Hat Ceph ストレージダッシュボードを使用して、ブロックデバイスイメージを監視および管理できます。イメージの詳細、スナップショット、設定の詳細、およびパフォーマンスの詳細を表示できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- rbd アプリケーションが有効になっているプールが作成されている。

- イメージが作成されている。

手順

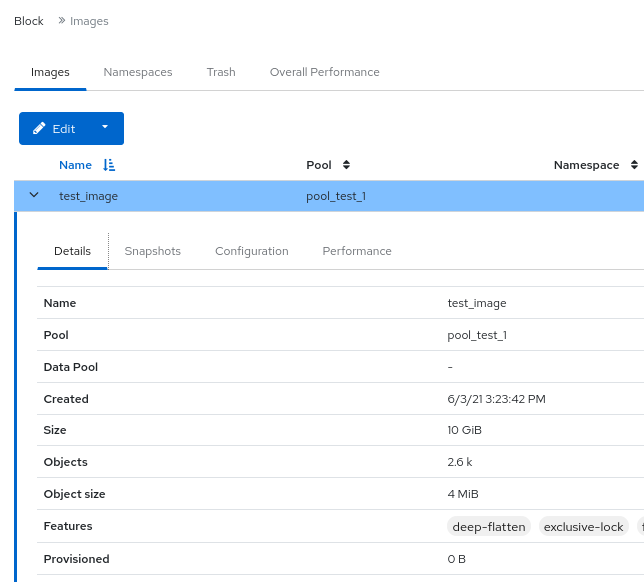

- ダッシュボードのナビゲーションから、Block→Images に移動します。

詳細情報を表示するには、イメージ行を展開します。

図6.14 ブロックデバイスイメージの監視

第7章 Ceph Dashboard でのアラートの管理

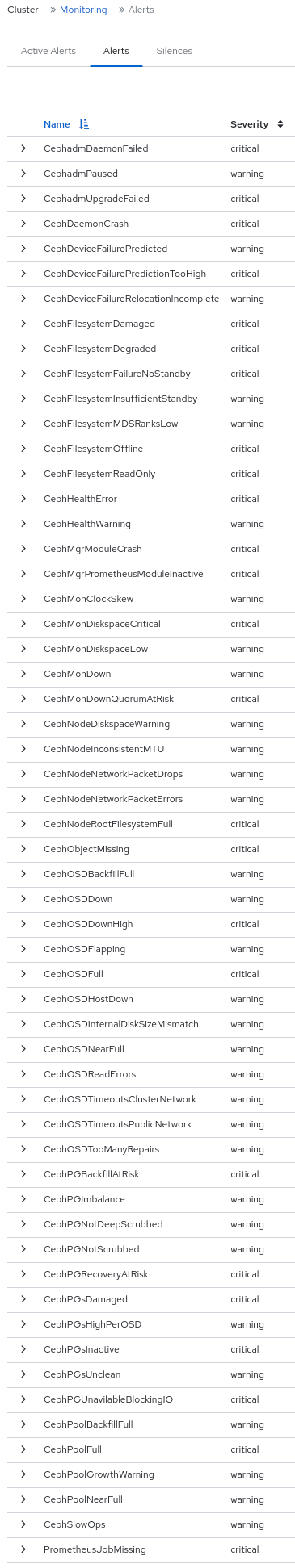

ストレージ管理者は、Red Hat Ceph Storage Dashboard でアラートの詳細を表示し、アラートのサイレンスを作成できます。これには、次の事前定義されたアラートが含まれます。

- CephadmDaemonFailed

- CephadmPaused

- CephadmUpgradeFailed

- CephDaemonCrash

- CephDeviceFailurePredicted

- CephDeviceFailurePredictionTooHigh

- CephDeviceFailureRelocationIncomplete

- CephFilesystemDamaged

- CephFilesystemDegraded

- CephFilesystemFailureNoStandby

- CephFilesystemInsufficientStandby

- CephFilesystemMDSRanksLow

- CephFilesystemOffline

- CephFilesystemReadOnly

- CephHealthError

- CephHealthWarning

- CephMgrModuleCrash

- CephMgrPrometheusModuleInactive

- CephMonClockSkew

- CephMonDiskspaceCritical

- CephMonDiskspaceLow

- CephMonDown

- CephMonDownQuorumAtRisk

- CephNodeDiskspaceWarning

- CephNodeInconsistentMTU

- CephNodeNetworkPacketDrops

- CephNodeNetworkPacketErrors

- CephNodeRootFilesystemFull

- CephObjectMissing

- CephOSDBackfillFull

- CephOSDDown

- CephOSDDownHigh

- CephOSDFlapping

- CephOSDFull

- CephOSDHostDown

- CephOSDInternalDiskSizeMismatch

- CephOSDNearFull

- CephOSDReadErrors

- CephOSDTimeoutsClusterNetwork

- CephOSDTimeoutsPublicNetwork

- CephOSDTooManyRepairs

- CephPGBackfillAtRisk

- CephPGImbalance

- CephPGNotDeepScrubbed

- CephPGNotScrubbed

- CephPGRecoveryAtRisk

- CephPGsDamaged

- CephPGsHighPerOSD

- CephPGsInactive

- CephPGsUnclean

- CephPGUnavilableBlockingIO

- CephPoolBackfillFull

- CephPoolFull

- CephPoolGrowthWarning

- CephPoolNearFull

- CephSlowOps

- PrometheusJobMissing

図7.1 事前定義されたアラート

簡易ネットワーク管理プロトコル (SNMP) トラップを使用してアラートを監視することもできます。

7.1. 監視スタックの有効化

コマンドラインインターフェイスを使用して、Prometheus、Alertmanager、Grafana などの Red Hat Ceph Storage クラスターのモニタリングスタックを手動で有効にできます。

Prometheus および Alertmanager API を使用して、アラートと無音を管理できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- すべてのホストへの root レベルのアクセス。

手順

cephadmシェルにログインします。例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow 監視スタックの API を設定します。

Alertmanager サーバーのホストとポートを指定します。

構文

ceph dashboard set-alertmanager-api-host ALERTMANAGER_API_HOST:PORT

ceph dashboard set-alertmanager-api-host ALERTMANAGER_API_HOST:PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph dashboard set-alertmanager-api-host http://10.0.0.101:9093 Option ALERTMANAGER_API_HOST updated

[ceph: root@host01 /]# ceph dashboard set-alertmanager-api-host http://10.0.0.101:9093 Option ALERTMANAGER_API_HOST updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 設定されたアラートを表示するには、Prometheus API への URL を設定します。この API を使用して、Ceph Dashboard UI は、新しい無音が対応するアラートと一致することを確認します。

構文

ceph dashboard set-prometheus-api-host PROMETHEUS_API_HOST:PORT

ceph dashboard set-prometheus-api-host PROMETHEUS_API_HOST:PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph dashboard set-prometheus-api-host http://10.0.0.101:9095 Option PROMETHEUS_API_HOST updated

[ceph: root@host01 /]# ceph dashboard set-prometheus-api-host http://10.0.0.101:9095 Option PROMETHEUS_API_HOST updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow ホストを設定した後、ブラウザーのダッシュボードウィンドウを更新します。

Grafana サーバーのホストとポートを指定します。

構文

ceph dashboard set-grafana-api-url GRAFANA_API_URL:PORT

ceph dashboard set-grafana-api-url GRAFANA_API_URL:PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph dashboard set-grafana-api-url https://10.0.0.101:3000 Option GRAFANA_API_URL updated

[ceph: root@host01 /]# ceph dashboard set-grafana-api-url https://10.0.0.101:3000 Option GRAFANA_API_URL updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Prometheus、Alertmanager、および Grafana API ホストの詳細を取得します。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: Prometheus、Alertmanager、または Grafana のセットアップで自己署名証明書を使用している場合は、ダッシュボードで証明書の検証を無効にします。これにより、不明な認証局 (CA) によって署名された証明書や、ホスト名と一致しない証明書が原因となる接続拒否を回避することができます。

Prometheus の場合:

例

[ceph: root@host01 /]# ceph dashboard set-prometheus-api-ssl-verify False

[ceph: root@host01 /]# ceph dashboard set-prometheus-api-ssl-verify FalseCopy to Clipboard Copied! Toggle word wrap Toggle overflow Alertmanager の場合:

例

[ceph: root@host01 /]# ceph dashboard set-alertmanager-api-ssl-verify False

[ceph: root@host01 /]# ceph dashboard set-alertmanager-api-ssl-verify FalseCopy to Clipboard Copied! Toggle word wrap Toggle overflow Grafana の場合:

例

[ceph: root@host01 /]# ceph dashboard set-grafana-api-ssl-verify False

[ceph: root@host01 /]# ceph dashboard set-grafana-api-ssl-verify FalseCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Prometheus、Alertmanager、および Grafana の自己署名証明書検証設定の詳細を取得します。

例

[ceph: root@host01 /]# ceph dashboard get-prometheus-api-ssl-verify [ceph: root@host01 /]# ceph dashboard get-alertmanager-api-ssl-verify [ceph: root@host01 /]# ceph dashboard get-grafana-api-ssl-verify

[ceph: root@host01 /]# ceph dashboard get-prometheus-api-ssl-verify [ceph: root@host01 /]# ceph dashboard get-alertmanager-api-ssl-verify [ceph: root@host01 /]# ceph dashboard get-grafana-api-ssl-verifyCopy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: ダッシュボードに変更が反映されていない場合は、ダッシュボードを無効にしてから有効にする必要があります。

例

[ceph: root@host01 /]# ceph mgr module disable dashboard [ceph: root@host01 /]# ceph mgr module enable dashboard

[ceph: root@host01 /]# ceph mgr module disable dashboard [ceph: root@host01 /]# ceph mgr module enable dashboardCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2. Grafana 証明書の設定

cephadm は、ceph キー/値ストアで定義された証明書を使用して Grafana をデプロイします。証明書が指定されていない場合、cephadm は Grafana サービスのデプロイメント中に自己署名証明書を生成します。

ceph config-key set コマンドを使用してカスタム証明書を設定できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

手順

cephadmシェルにログインします。例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow Grafana のカスタム証明書を設定します。

例

[ceph: root@host01 /]# ceph config-key set mgr/cephadm/grafana_key -i $PWD/key.pem [ceph: root@host01 /]# ceph config-key set mgr/cephadm/grafana_crt -i $PWD/certificate.pem

[ceph: root@host01 /]# ceph config-key set mgr/cephadm/grafana_key -i $PWD/key.pem [ceph: root@host01 /]# ceph config-key set mgr/cephadm/grafana_crt -i $PWD/certificate.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow Grafana がすでにデプロイされている場合は、

reconfigを実行して設定を更新します。例

[ceph: root@host01 /]# ceph orch reconfig grafana

[ceph: root@host01 /]# ceph orch reconfig grafanaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 新しい証明書を追加するたびに、次の手順に従います。

新しいディレクトリーを作成する

例

mkdir /root/internalca cd /root/internalca

[root@host01 ~]# mkdir /root/internalca [root@host01 ~]# cd /root/internalcaCopy to Clipboard Copied! Toggle word wrap Toggle overflow キーを生成します。

例

openssl ecparam -genkey -name secp384r1 -out $(date +%F).key

[root@host01 internalca]# openssl ecparam -genkey -name secp384r1 -out $(date +%F).keyCopy to Clipboard Copied! Toggle word wrap Toggle overflow キーを表示します。

例

openssl ec -text -in $(date +%F).key | less

[root@host01 internalca]# openssl ec -text -in $(date +%F).key | lessCopy to Clipboard Copied! Toggle word wrap Toggle overflow リクエストを行う:

例

umask 077; openssl req -config openssl-san.cnf -new -sha256 -key $(date +%F).key -out $(date +%F).csr

[root@host01 internalca]# umask 077; openssl req -config openssl-san.cnf -new -sha256 -key $(date +%F).key -out $(date +%F).csrCopy to Clipboard Copied! Toggle word wrap Toggle overflow 署名のために送信する前にリクエストを確認してください。

例

openssl req -text -in $(date +%F).csr | less

[root@host01 internalca]# openssl req -text -in $(date +%F).csr | lessCopy to Clipboard Copied! Toggle word wrap Toggle overflow CA サインとして:

例

openssl ca -extensions v3_req -in $(date +%F).csr -out $(date +%F).crt -extfile openssl-san.cnf

[root@host01 internalca]# openssl ca -extensions v3_req -in $(date +%F).csr -out $(date +%F).crt -extfile openssl-san.cnfCopy to Clipboard Copied! Toggle word wrap Toggle overflow 署名された証明書を確認します。

例

openssl x509 -text -in $(date +%F).crt -noout | less

[root@host01 internalca]# openssl x509 -text -in $(date +%F).crt -noout | lessCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3. Alertmanager Webhook の追加

新しい Webhook を既存の Alertmanager 設定に追加して、ストレージクラスターの正常性に関するリアルタイムのアラートを受け取ることができます。サードパーティーアプリケーションへの非同期メッセージを許可するには、着信 Webhook を有効にする必要があります。

たとえば、Red Hat Ceph Storage クラスターで OSD がダウンしている場合、Alertmanager を設定して Google チャットで通知を送信できます。

前提条件

- モニタリングスタックコンポーネントが有効になっている実行中の Red Hat Ceph Storage クラスター。

- 受信側のサードパーティーアプリケーションで設定された着信 Webhook。

手順

cephadmシェルにログインします。例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow Alertmanager が通知のために Webhook を使用するように設定します。

構文

service_type: alertmanager spec: user_data: default_webhook_urls: - "_URLS_"service_type: alertmanager spec: user_data: default_webhook_urls: - "_URLS_"Copy to Clipboard Copied! Toggle word wrap Toggle overflow default_webhook_urlsは、デフォルトの受信者のwebhook_configs設定に追加される追加の URL のリストです。例

service_type: alertmanager spec: user_data: webhook_configs: - url: 'http:127.0.0.10:8080'service_type: alertmanager spec: user_data: webhook_configs: - url: 'http:127.0.0.10:8080'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Alertmanager 設定を更新します。

例

[ceph: root@host01 /]# ceph orch reconfig alertmanager

[ceph: root@host01 /]# ceph orch reconfig alertmanagerCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

Alertmanager から Gchat への通知の例:

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4. Ceph Dashboard でのアラートの表示

アラートが起動したら、Red Hat Ceph Storage Dashboard でアラートを表示できます。Manager module の設定を編集して、アラートが発行されたときにメールをトリガーできます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- 実行中の簡単なメール転送プロトコル (SMTP) が設定されている。

- アラートが発行されました。

手順

- ダッシュボードのナビゲーションから、Observability→Alerts に移動します。

- Active Alerts タブからアクティブな Prometheus アラートを表示します。

Alerts タブからすべてのアラートを表示します。

アラートの詳細を表示するには、アラートの行を展開します。

アラートのソースを表示するには、その行をクリックし、Source をクリックします。

7.5. Ceph Dashboard でのサイレンスの作成

Red Hat Ceph Storage Dashboard で、アラートを一定期間サイレントに作成できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- アラートが発生している。

手順

- ダッシュボードのナビゲーションから、Observability→Alerts に移動します。

- Silences タブで、Create をクリックします。

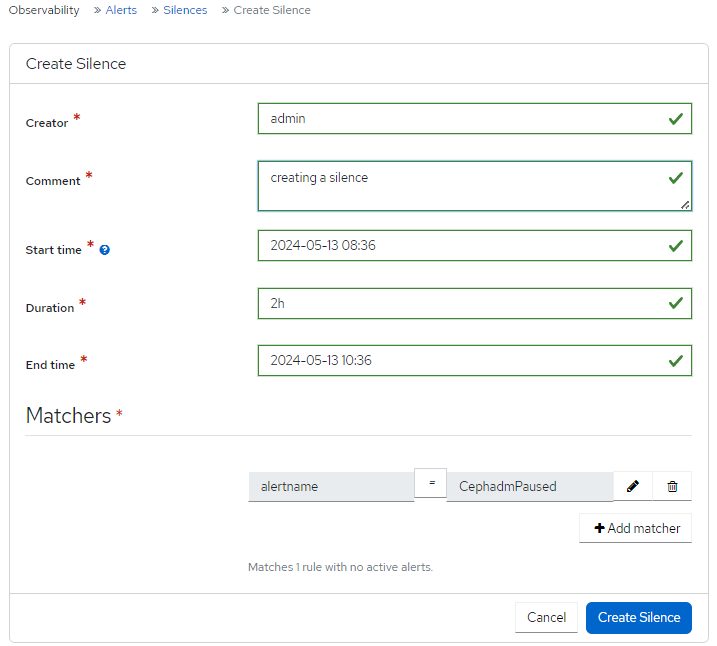

Create Silence フォームで、必須フィールドに入力します。

Add matcher を使用して、サイレンス要件を追加します。

図7.2 サイレンスの作成

Create Silence をクリックします。

サイレンスが正常に作成されたことを示す通知が表示され、Silences テーブル内の Alerts Silenced が更新されます。

7.6. Ceph ダッシュボードでのサイレンスの再作成

Red Hat Ceph Storage ダッシュボードで、期限切れのサイレンスをもとにサイレンスを再作成できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- アラートが発生している。

- アラートのサイレンスが作成されている。

手順

- ダッシュボードのナビゲーションから、Observability→Alerts に移動します。

- Silences タブで、再作成するアラートの行を選択し、アクションドロップダウンから Recreate をクリックします。

必要な詳細を編集し、Recreate Silence ボタンをクリックします。

サイレンスが正常に編集されたことを示す通知が表示され、サイレンスのステータスが active になります。

7.7. Ceph Dashboard でのサイレンスの編集

アクティブなサイレンスは、Red Hat Ceph Storage Dashboard でアクティブな時間を延長するなど、編集が可能です。サイレンスの有効期限が切れている場合は、サイレンスを再作成するか、アラート用に新しいサイレンスを作成することができます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- アラートが発生している。

- アラートのサイレンスが作成されている。

手順

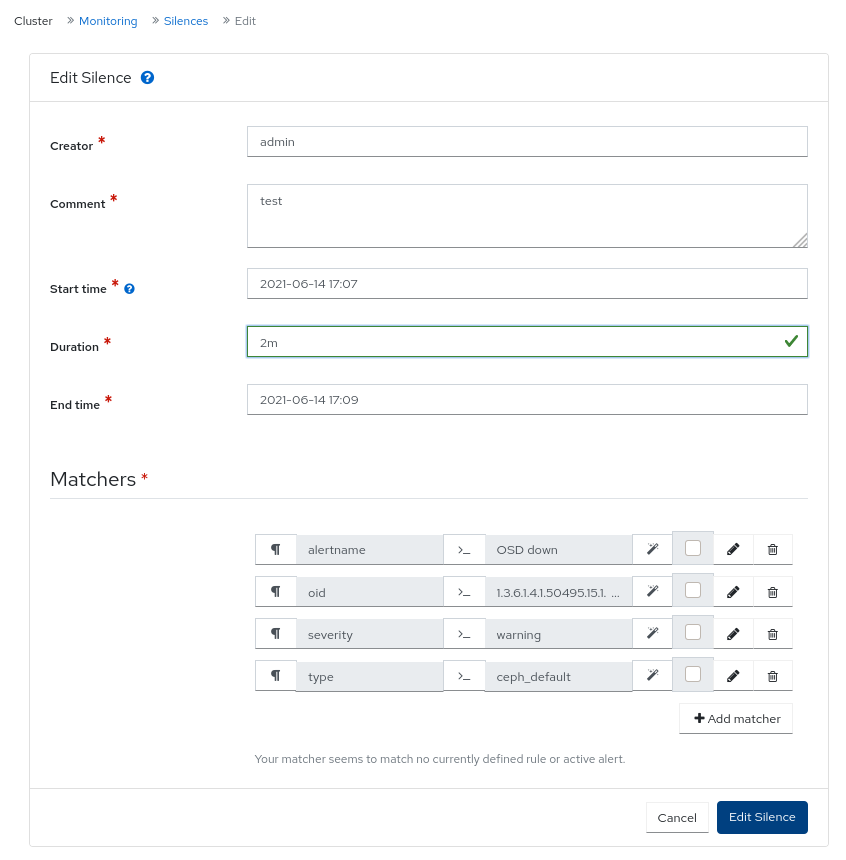

- ダッシュボードにログインします。

- ナビゲーションメニューで、Cluster をクリックします。

- ドロップダウンメニューから Monitoring を選択します。

- Silences タブをクリックします。

- サイレンスを編集するには、その行をクリックします。

- Edit ドロップダウンメニューで、Edit を選択します。

Edit Silence ウィンドウで、詳細を更新し、Edit Silence をクリックします。

図7.3 サイレンスの編集

- サイレンスが正常に更新されたという通知が表示されます。

7.8. Ceph Dashboard でのサイレンスの失効

Red Hat Ceph Storage Dashboard で一致したアラートが抑制されないように、サイレンスを期限切れにすることができます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Dashboard がインストールされている。

- アラートが発生している。

- アラートのサイレンスが作成されている。

手順

- ダッシュボードのナビゲーションから、Observability→Alerts に移動します。

- Silences タブで、期限切れするアラートの行を選択し、アクションドロップダウンから Expire をクリックします。

Expire Silence 通知で、Yes, I am sure を選択し、Expire Silence をクリックします。

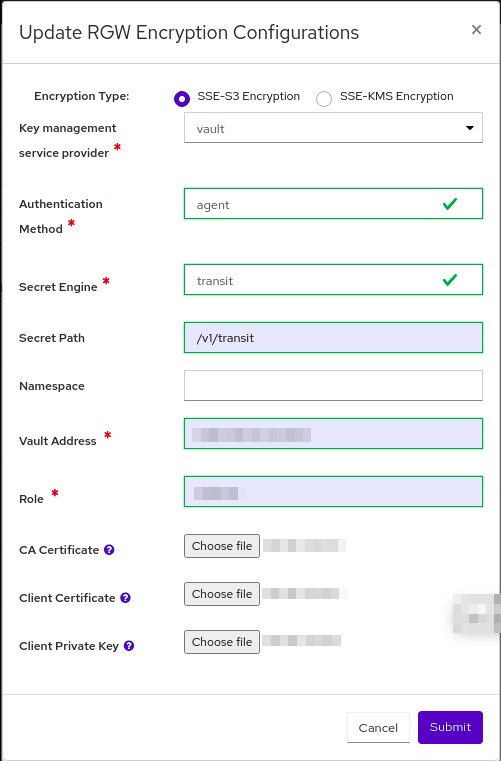

サイレンスが正常に期限切れになったことを示す通知が表示され、Silences テーブルでサイレンスステータスが expired になります。