ブロックデバイスガイド

Red Hat Ceph Storage ブロックデバイスの管理、作成、設定、および使用

概要

第1章 Ceph ブロックデバイスの概要

ブロックは、シーケンスでのデータの長さ (例: 512 バイトのデータブロック) をバイト単位で設定したものです。多くのブロックを 1 つのファイルに統合すると、読み取り/書き込みが可能なストレージデバイスとして使用できます。以下のような回転メディアを使用してデータを保存する最も一般的な方法として、ブロックベースのストレージインターフェイスが挙げられます。

- ハードドライブ

- CD/DVD ディスク

- フロッピーディスク

- 従来の 9 トラックテープ

ブロックデバイスインターフェイスの普及により、仮想ブロックデバイスは、Red Hat Ceph Storage のような大容量データストレージシステムと対話するための理想的な候補になります。

Ceph ブロックデバイスはシンプロビジョニングされ、サイズ変更可能で、Ceph Storage クラスター内の複数のオブジェクトストレージデバイス (OSD) にストライプ化されたデータを保存します。Ceph ブロックデバイスは、Reliable Autonomic Distributed Object Store (RADOS) ブロックデバイス (RBD) としても知られています。Ceph ブロックデバイスは、以下のような RADOS 機能を利用します。

- スナップショット

- レプリケーション

- データの整合性

Ceph ブロックデバイスは、librbd ライブラリーを使用して OSD と対話します。

Ceph ブロックデバイスは、libvirt ユーティリティーおよび QEMU ユーティリティーに依存して Ceph ブロックデバイスと統合するために、Quick Emulator (QEMU) などの Kernel Virtual Machines (KVM) や OpenStack などのクラウドベースのコンピューティングシステムに、無限のスケーラビリティーと、高いパフォーマンスをもたらします。同じストレージクラスターを使用して、Ceph Object Gateway および Ceph ブロックデバイスを同時に運用できます。

Ceph ブロックデバイスを使用するには、実行中の Ceph Storage クラスターにアクセスできるようにする必要があります。Red Hat Ceph Storage クラスターのインストールの詳細は、Red Hat Ceph Storage インストールガイド を参照してください。

第2章 Ceph ブロックデバイス

ストレージ管理者は、Ceph のブロックデバイスコマンドを理解しておくと、Red Hat Ceph Storage クラスターを効果的に管理しやすくなります。Ceph ブロックデバイスのさまざまな機能を有効または無効にしたり、ブロックデバイスのプールとイメージを作成および管理したりできます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

2.1. コマンドのヘルプの表示

コマンドラインインターフェイスから、コマンドとサブコマンドのヘルプを表示します。

-h オプションは引き続き、使用できるすべてのコマンドのヘルプを表示します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

rbd helpコマンドを使用して、特定のrbdコマンドとそのサブコマンドのヘルプを表示します。構文

rbd help COMMAND SUBCOMMAND

rbd help COMMAND SUBCOMMANDCopy to Clipboard Copied! Toggle word wrap Toggle overflow snap listコマンドのヘルプを表示するには、次のコマンドを実行します。rbd help snap list

[root@rbd-client ~]# rbd help snap listCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2. ブロックデバイスプールの作成

ブロックデバイスクライアントを使用する前に、rbd のプールが存在し、初期化されていることを確認します。

最初にプールを作成してから、これをソースとして指定する 必要があります。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

rbdプールを作成するには、以下を実行します。構文

ceph osd pool create POOL_NAME PG_NUM ceph osd pool application enable POOL_NAME rbd rbd pool init -p POOL_NAME

ceph osd pool create POOL_NAME PG_NUM ceph osd pool application enable POOL_NAME rbd rbd pool init -p POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

ceph osd pool create pool1 ceph osd pool application enable pool1 rbd rbd pool init -p pool1

[root@rbd-client ~]# ceph osd pool create pool1 [root@rbd-client ~]# ceph osd pool application enable pool1 rbd [root@rbd-client ~]# rbd pool init -p pool1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

関連情報

- 詳細は、Red Hat Ceph Storage ストラテジーガイド の プール の章を参照してください。

2.3. ブロックデバイスイメージの作成

ブロックデバイスをノードに追加する前に、Ceph Storage クラスターにそのイメージを作成します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

ブロックデバイスイメージを作成するには、以下のコマンドを実行します。

構文

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd create image1 --size 1024 --pool pool1

[root@rbd-client ~]# rbd create image1 --size 1024 --pool pool1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例では、

pool1という名前のプールに情報を格納するimage1という名前のイメージが 1 GB のサイズで作成されます。注記イメージを作成する前に、プールが存在することを確認します。

関連情報

- 詳細は、Red Hat Ceph Storage ブロックデバイスガイド の ブロックデバイスプールの作成 セクションを参照してください。

2.4. ブロックデバイスイメージのリスト表示

ブロックデバイスイメージをリスト表示します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

rbdプールのブロックデバイスをリスト表示するには、以下を実行します。注記RBDはデフォルトのプール名です。例

rbd ls

[root@rbd-client ~]# rbd lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 特定のプールのブロックデバイスをリスト表示するには、以下を実行します。

構文

rbd ls POOL_NAME

rbd ls POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd ls pool1

[root@rbd-client ~]# rbd ls pool1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5. ブロックデバイスイメージ情報の取得

ブロックデバイスイメージに関する情報を取得します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

デフォルトの

rbdプールの特定イメージから情報を取得するには、以下のコマンドを実行します。構文

rbd --image IMAGE_NAME info

rbd --image IMAGE_NAME infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --image image1 info

[root@rbd-client ~]# rbd --image image1 infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow プール内のイメージから情報を取得するには、以下を実行します。

構文

rbd --image IMAGE_NAME -p POOL_NAME info

rbd --image IMAGE_NAME -p POOL_NAME infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --image image1 -p pool1 info

[root@rbd-client ~]# rbd --image image1 -p pool1 infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6. ブロックデバイスイメージのサイズ変更

Ceph ブロックデバイスイメージはシンプロビジョニングされています。データの保存を開始する前に、実際には物理ストレージを使用しません。ただし、--size オプションでは、設定する最大容量があります。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

デフォルトの

rbdプールの Ceph ブロックデバイスイメージの最大サイズを増減するには、以下を実行します。構文

rbd resize --image IMAGE_NAME --size SIZE

rbd resize --image IMAGE_NAME --size SIZECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd resize --image image1 --size 1024

[root@rbd-client ~]# rbd resize --image image1 --size 1024Copy to Clipboard Copied! Toggle word wrap Toggle overflow 特定のプールの Ceph ブロックデバイスイメージの最大サイズを増減するには、以下を実行します。

構文

rbd resize --image POOL_NAME/IMAGE_NAME --size SIZE

rbd resize --image POOL_NAME/IMAGE_NAME --size SIZECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd resize --image pool1/image1 --size 1024

[root@rbd-client ~]# rbd resize --image pool1/image1 --size 1024Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7. ブロックデバイスイメージの削除

ブロックデバイスイメージを削除します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

デフォルトの

rbdプールからブロックデバイスを削除するには、次のコマンドを実行します。構文

rbd rm IMAGE_NAME

rbd rm IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd rm image1

[root@rbd-client ~]# rbd rm image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 特定のプールからブロックデバイスを削除するには、次のコマンドを実行します。

構文

rbd rm IMAGE_NAME -p POOL_NAME

rbd rm IMAGE_NAME -p POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd rm image1 -p pool1

[root@rbd-client ~]# rbd rm image1 -p pool1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.8. ブロックデバイスイメージのゴミ箱への移行

RADOS Block Device (RBD) イメージは、rbd trash コマンドを使用してゴミ箱に移動できます。このコマンドは、rbd rm コマンドよりも多くのオプションがあります。

イメージをゴミ箱に移動すると、後でゴミ箱から取り除くこともできます。この機能により、誤って削除されるのを回避できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

イメージをゴミ箱に移動するには、以下のコマンドを実行します。

構文

rbd trash mv [POOL_NAME/] IMAGE_NAME

rbd trash mv [POOL_NAME/] IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd trash mv pool1/image1

[root@rbd-client ~]# rbd trash mv pool1/image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow イメージがゴミ箱に入ると、一意のイメージ ID が割り当てられます。

注記ゴミ箱オプションのいずれかを使用する必要がある場合は、後でこのイメージを指定するのにこのイメージ ID が必要です。

-

ゴミ箱にあるイメージ ID のリストに対して

rbd trash list POOL_NAMEを実行します。このコマンドは、イメージの削除前の名前も返します。さらに、rbd infoおよびrbd snapコマンドで使用可能な--image-id引数 (任意) があります。rbd infoコマンドに--image-idを使用し、ごみ箱の中にあるイメージのプロパティーを表示し、rbd snapで、イメージのスナップショットをゴミ箱から削除します。 ゴミ箱からイメージを削除するには、以下のコマンドを実行します。

構文

rbd trash rm [POOL_NAME/] IMAGE_ID

rbd trash rm [POOL_NAME/] IMAGE_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd trash rm pool1/d35ed01706a0

[root@rbd-client ~]# rbd trash rm pool1/d35ed01706a0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要イメージがゴミ箱から削除されると、そのイメージは復元できません。

rbd trash restoreコマンドを実行して、イメージを復元します。構文

rbd trash restore [POOL_NAME/] IMAGE_ID

rbd trash restore [POOL_NAME/] IMAGE_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd trash restore pool1/d35ed01706a0

[root@rbd-client ~]# rbd trash restore pool1/d35ed01706a0Copy to Clipboard Copied! Toggle word wrap Toggle overflow ゴミ箱から期限切れのイメージをすべて削除するには、以下のコマンドを実行します。

構文

rbd trash purge POOL_NAME

rbd trash purge POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd trash purge pool1

[root@rbd-client ~]# rbd trash purge pool1 Removing images: 100% complete...done.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.9. ゴミ箱の自動パージスケジュールの定義

プールでゴミ箱のパージ操作を定期的にスケジュールできます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

ゴミ箱のパージのスケジュールを追加するには、以下のコマンドを実行します。

構文

rbd trash purge schedule add --pool POOL_NAME INTERVAL

rbd trash purge schedule add --pool POOL_NAME INTERVALCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# rbd trash purge schedule add --pool pool1 10m

[ceph: root@host01 /]# rbd trash purge schedule add --pool pool1 10mCopy to Clipboard Copied! Toggle word wrap Toggle overflow ゴミ箱のパージのスケジュールをリスト表示するには、以下のコマンドを実行します。

構文

rbd trash purge schedule ls --pool POOL_NAME

rbd trash purge schedule ls --pool POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# rbd trash purge schedule ls --pool pool1 every 10m

[ceph: root@host01 /]# rbd trash purge schedule ls --pool pool1 every 10mCopy to Clipboard Copied! Toggle word wrap Toggle overflow ゴミ箱のパージスケジュールの状態を把握するには、以下を実行します。

例

[ceph: root@host01 /]# rbd trash purge schedule status POOL NAMESPACE SCHEDULE TIME pool1 2021-08-02 11:50:00

[ceph: root@host01 /]# rbd trash purge schedule status POOL NAMESPACE SCHEDULE TIME pool1 2021-08-02 11:50:00Copy to Clipboard Copied! Toggle word wrap Toggle overflow ゴミ箱のパージスケジュールを削除するには、以下のコマンドを実行します。

構文

rbd trash purge schedule remove --pool POOL_NAME INTERVAL

rbd trash purge schedule remove --pool POOL_NAME INTERVALCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# rbd trash purge schedule remove --pool pool1 10m

[ceph: root@host01 /]# rbd trash purge schedule remove --pool pool1 10mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.10. イメージ機能の有効化および無効化

fast-diff、exclusive-lock、object-map、deep-flatten などのブロックデバイスイメージはデフォルトで有効です。これらのイメージ機能は、すでに存在するイメージに対して有効/無効を設定することができます。

ディープフラット化 機能は、既存のイメージでのみ無効にできますが、有効化できません。ディープフラット化 を使用するには、イメージ作成時に有効化します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

プール内の特定のイメージから情報を取得します。

構文

rbd --image POOL_NAME/IMAGE_NAME info

rbd --image POOL_NAME/IMAGE_NAME infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# rbd --image pool1/image1 info

[ceph: root@host01 /]# rbd --image pool1/image1 infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 機能を有効にします。

構文

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE_NAME

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow pool1プールのimage1イメージでexclusive-lock機能を有効にするには、以下を実行します。例

[ceph: root@host01 /]# rbd feature enable pool1/image1 exclusive-lock

[ceph: root@host01 /]# rbd feature enable pool1/image1 exclusive-lockCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要fast-diffおよびobject-map機能を有効にする場合には、オブジェクトマップを再構築します。+ 構文

rbd object-map rebuild POOL_NAME/IMAGE_NAME

rbd object-map rebuild POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow

機能を無効にします。

構文

rbd feature disable POOL_NAME/IMAGE_NAME FEATURE_NAME

rbd feature disable POOL_NAME/IMAGE_NAME FEATURE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow pool1プールのimage1イメージでfast-diff機能を無効にするには、以下を実行します。例

[ceph: root@host01 /]# rbd feature disable pool1/image1 fast-diff

[ceph: root@host01 /]# rbd feature disable pool1/image1 fast-diffCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.11. イメージメタデータの使用

Ceph は、カスタムイメージメタデータをキーと値のペアとして追加することをサポートしています。ペアには厳密な形式がありません。

また、メタデータを使用して特定のイメージの RADOS Block Device (RBD) 設定パラメーターを設定することもできます。

rbd image-meta コマンドを使用して、メタデータと連携します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- クライアントノードへの root レベルのアクセス。

手順

新しいメタデータのキー/値のペアを設定するには、以下を行います。

構文

rbd image-meta set POOL_NAME/IMAGE_NAME KEY VALUE

rbd image-meta set POOL_NAME/IMAGE_NAME KEY VALUECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# rbd image-meta set pool1/image1 last_update 2021-06-06

[ceph: root@host01 /]# rbd image-meta set pool1/image1 last_update 2021-06-06Copy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

pool1プールのimage1イメージのlast_updateキーを、2021-06-06値に設定します。キーの値を表示するには、次のコマンドを実行します。

構文

rbd image-meta get POOL_NAME/IMAGE_NAME KEY

rbd image-meta get POOL_NAME/IMAGE_NAME KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# rbd image-meta get pool1/image1 last_update

[ceph: root@host01 /]# rbd image-meta get pool1/image1 last_updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

last_updateキーの値を確認します。イメージの全メタデータを表示するには、以下のコマンドを実行します。

構文

rbd image-meta list POOL_NAME/IMAGE_NAME

rbd image-meta list POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# rbd image-meta list pool1/image1

[ceph: root@host01 /]# rbd image-meta list pool1/image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

pool1プールのimage1イメージに設定されたメタデータをリスト表示しています。メタデータのキー/値のペアを削除するには、以下を実行します。

構文

rbd image-meta remove POOL_NAME/IMAGE_NAME KEY

rbd image-meta remove POOL_NAME/IMAGE_NAME KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# rbd image-meta remove pool1/image1 last_update

[ceph: root@host01 /]# rbd image-meta remove pool1/image1 last_updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

pool1プール内のimage1イメージからlast_updateのキーと値のペアを削除します。特定のイメージの Ceph 設定ファイルに設定されている RBD イメージ設定を上書きするには、以下を実行します。

構文

rbd config image set POOL_NAME/IMAGE_NAME PARAMETER VALUE

rbd config image set POOL_NAME/IMAGE_NAME PARAMETER VALUECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# rbd config image set pool1/image1 rbd_cache false

[ceph: root@host01 /]# rbd config image set pool1/image1 rbd_cache falseCopy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

pool1プールのimage1イメージの RBD キャッシュを無効にします。

2.12. プール間のイメージの移動

同じクラスターにある異なるプール間で RADOS Block Device (RBD) イメージを移動できます。

このプロセスで、ソースイメージはすべてのスナップショット履歴を含めて、ターゲットイメージにコピーされます。また、オプションでスパースの保持に役立つソースイメージの親へのリンクもコピーされます。ソースイメージは読み取り専用で、ターゲットイメージは書き込み可能です。移行時に、ターゲットイメージがソースイメージにリンクされます。

このプロセスは、新規ターゲットイメージの使用中に、バックグラウンドで安全に実行できます。ただし、新規ターゲットのイメージが、イメージを使用するクライアントの参照先として更新されるように、準備手順前にターゲットイメージを使用してすべてのクライアントを停止してください。

現時点では、krbd カーネルモジュールはライブ移行に対応していません。

前提条件

- ソースイメージを使用するすべてのクライアントを停止しておく。

- クライアントノードへの root レベルのアクセス。

手順

ソースおよびターゲットイメージをクロスリンクする新規ターゲットイメージを作成して、移行を準備します。

構文

rbd migration prepare SOURCE_IMAGE TARGET_IMAGE

rbd migration prepare SOURCE_IMAGE TARGET_IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下を置き換えます。

- SOURCE_IMAGE: 移動するイメージの名前に置き換えます。POOL/IMAGE_NAME 形式を使用します。

- TARGET_IMAGE: 新しいイメージの名前。POOL/IMAGE_NAME 形式を使用します。

例

rbd migration prepare pool1/image1 pool2/image2

[root@rbd-client ~]# rbd migration prepare pool1/image1 pool2/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 新しいターゲットイメージの状態を確認します。

preparedとなっているはずです。構文

rbd status TARGET_IMAGE

rbd status TARGET_IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 必要に応じて、新規ターゲットイメージ名を使用してクライアントを再起動します。

ソースイメージをターゲットイメージにコピーします。

構文

rbd migration execute TARGET_IMAGE

rbd migration execute TARGET_IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd migration execute pool2/image2

[root@rbd-client ~]# rbd migration execute pool2/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 移行が完了したことを確認します。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ソースとターゲットイメージ間のクロスリンクを削除して移行をコミットします。これにより、ソースイメージも削除されます。

構文

rbd migration commit TARGET_IMAGE

rbd migration commit TARGET_IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd migration commit pool2/image2

[root@rbd-client ~]# rbd migration commit pool2/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow ソースイメージが 1 つ以上のクローンの親である場合は、クローンイメージが使用されていないことを確認した後に

--forceオプションを使用します。例

rbd migration commit pool2/image2 --force

[root@rbd-client ~]# rbd migration commit pool2/image2 --forceCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 準備手順の後にクライアントを再起動しなかった場合は、新規ターゲットイメージ名を使用してクライアントを再起動します。

2.13. プールの移行

RADOS ブロックデバイス (RBD) イメージを移行またはコピーできます。

このプロセスでは、ソースイメージがエクスポートされてからインポートされます。

ワークロードに RBD イメージ のみ が含まれている場合は、この移行プロセスを使用します。ワークロード内に rados cppool イメージを存在させることはできません。ワークロードに rados cppool イメージが存在する場合は、ストレージストラテジーガイド の プールの移行 を参照してください。

エクスポートおよびインポートコマンドを実行するときは、関連する RBD イメージにアクティブな I/O がないことを確認してください。このプールの移行期間中は、運用を停止することを推奨します。

前提条件

- エクスポートおよびインポート中の RBD イメージ内のすべてのアクティブな I/O を停止する。

- クライアントノードへの root レベルのアクセス。

手順

ボリュームを移行します。

構文

rbd export volumes/VOLUME_NAME - | rbd import --image-format 2 - volumes_new/VOLUME_NAME

rbd export volumes/VOLUME_NAME - | rbd import --image-format 2 - volumes_new/VOLUME_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd export volumes/volume-3c4c63e3-3208-436f-9585-fee4e2a3de16 - | rbd import --image-format 2 - volumes_new/volume-3c4c63e3-3208-436f-9585-fee4e2a3de16

[root@rbd-client ~]# rbd export volumes/volume-3c4c63e3-3208-436f-9585-fee4e2a3de16 - | rbd import --image-format 2 - volumes_new/volume-3c4c63e3-3208-436f-9585-fee4e2a3de16Copy to Clipboard Copied! Toggle word wrap Toggle overflow インポートまたはエクスポートにローカルドライブを使用する必要がある場合は、コマンドを分割して、最初にローカルドライブにエクスポートし、次にファイルを新しいプールにインポートできます。

構文

rbd export volume/VOLUME_NAME FILE_PATH rbd import --image-format 2 FILE_PATH volumes_new/VOLUME_NAME

rbd export volume/VOLUME_NAME FILE_PATH rbd import --image-format 2 FILE_PATH volumes_new/VOLUME_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd export volumes/volume-3c4c63e3-3208-436f-9585-fee4e2a3de16 <path of export file> rbd import --image-format 2 <path> volumes_new/volume-3c4c63e3-3208-436f-9585-fee4e2a3de16

[root@rbd-client ~]# rbd export volumes/volume-3c4c63e3-3208-436f-9585-fee4e2a3de16 <path of export file> [root@rbd-client ~]# rbd import --image-format 2 <path> volumes_new/volume-3c4c63e3-3208-436f-9585-fee4e2a3de16Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.14. rbdmap サービス

systemd ユニットファイル、rbdmap.service は、ceph-common パッケージに含まれています。rbdmap.service ユニットは、rbdmap シェルスクリプトを実行します。

このスクリプトは、1 つ以上の RBD イメージの RADOS Block Device (RBD) のマッピングと解除を自動化しています。スクリプトはいつでも手動で実行できますが、通常のユースケースでは、システムの起動時に RBD イメージを自動的にマウントし、シャットダウン時にアンマウントします。スクリプトでは、RBD イメージをマウントする map またはマウントを解除する unmap のいずれか 1 つの引数を使用できます。。スクリプトは設定ファイルを解析します。デフォルトは /etc/ceph/rbdmap ですが、RBDMAPFILE という環境変数を使用して上書きできます。設定ファイルの各行は RBD イメージに対応します。

設定ファイルの形式は以下のようになります。

IMAGE_SPEC RBD_OPTS

ここで、IMAGE_SPEC は POOL_NAME / IMAGE_NAME、または IMAGE_NAME だけを指定します。IMAGE_NAME だけを指定する場合は、POOL_NAME は rbd に設定されます。RBD_OPTS は、基礎となる rbd map コマンドに渡すオプションのリストです。以下のパラメーターとその値は、コンマ区切りの文字列で指定する必要があります。

OPT1=VAL1,OPT2=VAL2,…,OPT_N=VAL_N

これにより、スクリプトは以下のような rbd map コマンドを実行します。

構文

rbd map POOLNAME/IMAGE_NAME --OPT1 VAL1 --OPT2 VAL2

rbd map POOLNAME/IMAGE_NAME --OPT1 VAL1 --OPT2 VAL2コンマや等号を含むオプションや値の場合は、単純なアポストロフィを使用して、それらが置き換えられないようにできます。

成功すると、rbd map の操作はイメージを /dev/rbd/rbdX デバイスにマッピングします。この時点で、udev ルールがトリガーされ、分かりやすいデバイス名のシンボリックリンク (例: /dev/rbd/POOL_NAME/IMAGE_NAME) を作成し、実際のマップされたデバイスを参照します。マウントまたはマウント解除を行うには、わかりやすいデバイス名に対応するエントリーを /etc/fstab ファイルに指定する必要があります。RBD イメージの /etc/fstab エントリーを作成する場合は、noauto または nofail マウントオプションを指定することが推奨されます。これにより、init システムが、デバイスの作成前に、先にマウントするのを防ぎます。

2.15. rbdmap サービスの設定

起動時に RADOS Block Device (RBD)、またはシャットダウン時に RADOS Block Device (RBD) を自動的にマップしてマウントするか、マップとマウントを解除します。

前提条件

- マウントを実行するノードへの Root レベルのアクセス。

-

ceph-commonパッケージのインストール。

手順

-

/etc/ceph/rbdmap設定ファイルを開いて編集します。 RBD イメージを設定ファイルに追加します。

例

foo/bar1 id=admin,keyring=/etc/ceph/ceph.client.admin.keyring foo/bar2 id=admin,keyring=/etc/ceph/ceph.client.admin.keyring,options='lock_on_read,queue_depth=1024'

foo/bar1 id=admin,keyring=/etc/ceph/ceph.client.admin.keyring foo/bar2 id=admin,keyring=/etc/ceph/ceph.client.admin.keyring,options='lock_on_read,queue_depth=1024'Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 設定ファイルに加えた変更を保存します。

RBD マッピングサービスを有効にします。

例

systemctl enable rbdmap.service

[root@client ~]# systemctl enable rbdmap.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.16. 永続的な書き込みログキャッシュ

Red Hat Ceph Storage クラスターでは、永続的な書き込みログ (PWL) キャッシュが librbd ベースの RBD クライアントに対して永続的で耐障害性のあるライトバックキャッシュを提供します。

PWL キャッシュは、ログ順序付けされたライトバック設計を使用しており、チェックポイントを内部的に維持しているため、クラスターにフラッシュバックされる書き込みは常にクラッシュ整合性が保たれます。クライアントキャッシュが完全になくなった場合、ディスクイメージには整合性がありますが、データが古くなったように見えます。キャッシュデバイスとして、PMEM (永続メモリー) や SSD (Solid State Disk) を使用して PWL キャッシュを使用できます。

PMEM の場合、キャッシュモードはレプリカ書き込みログ (RWL) で、SSD の場合はキャッシュモードが SSD になります。現在、PWL キャッシュは RWL および SSD モードに対応しており、デフォルトでは無効になっています。

PWL キャッシュの主な利点は次のとおりです。

- PWL キャッシュは、キャッシュが満杯でない場合は、高パフォーマンスを提供できます。キャッシュが大きいほど、高パフォーマンスの期間が長くなります。

- PWL キャッシュは永続性を提供し、RBD キャッシュと比較してそれほど遅くはありません。RBD キャッシュは高速ですが揮発性で、データの順番と永続性を保証することはできません。

- キャッシュが満杯の定常状態では、性能はインフライト I/O の数に影響されます。たとえば、PWL は io_depth が低い場合には高い性能を発揮しますが、I/O 数が 32 を超えるような高い io_depth では、キャッシュがない場合よりも性能が悪くなることが多いです。

PMEM キャッシュのユースケースは以下のとおりです。

- RBD キャッシュとは異なり、PWL キャッシュには不揮発性の特性があり、データ損失を避けたいが高パフォーマンスを必要とするシナリオで使用されます。

- RWL モードは、低レイテンシーを提供します。バースト I/O の場合安定した低レイテンシーを実現し、安定した低レイテンシーへの要求が高いシナリオに適しています。

- また、RWL モードでは、I/O 深度が低い、またはインフライト I/O が多すぎない状況において、連続的に安定した高い性能向上を実現しています。

SSD キャッシュのユースケースは以下のとおりです。

- SSD モードの利点は RWL モードと似ています。SSD ハードウェアは比較的安価で一般的ですが、そのパフォーマンスは PMEM よりも若干低くなります。

2.17. 永続的な書き込みログキャッシュの制約

永続的な書き込みログ (PWL) キャッシュを使用する場合は、考慮する必要のあるいくつかの制約があります。

- 永続メモリー (PMEM) とソリッドステートディスク (SSD) では、根本的な実装が異なり、PMEM の方が高性能です。現在、PMEM は "書き込み時の永続性" を、SSD は "フラッシュまたはチェックポイントの永続性" を提供することができます。今後のリリースでは、この 2 つのモードが設定できるようになる予定です。

-

ユーザーがイメージを頻繁に切り替え、開閉を繰り返すと、Ceph のパフォーマンスが低下します。PWL キャッシュが有効な場合には、パフォーマンスは悪化します。Flexible I/O (fio) テストで

num_jobsを設定することは推奨されません。その代わりに、複数のジョブが異なるイメージを書き込むように設定します。

2.18. 永続的な書き込みログキャッシュの有効化

Ceph RADOS ブロックデバイス (RBD) の rbd_persistent_cache_mode および rbd_plugins オプションを設定すると、Red Hat Ceph Storage クラスターで永続的な書き込みログキャッシュ (PWL) を有効にすることができます。

永続的な書き込みログキャッシュを有効にするには、排他的ロック機能を有効にする必要があります。キャッシュは、排他的ロックを取得した後にのみ読み込むことができます。排他的ロックは、rbd_default_features 設定オプションまたは rbd create コマンドの --image-feature フラグで上書きされない限り、新規に作成されたイメージでデフォルトで有効にされます。排他ロック 機能の詳細は、イメージ機能の有効化と無効化 セクションを参照してください。

ceph config set コマンドを使用して、ホストレベルで永続的な書き込みログキャッシュオプションを設定します。プールまたはイメージレベルで永続的な書き込みログキャッシュオプションを設定するには、rbd config pool set または rbd config image set コマンドを使用します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- monitor ノードへのルートレベルのアクセス。

- 排他的ロック機能が有効になっている。

- クライアント側のディスクが永続メモリー (PMEM) またはソリッドステートディスク (SSD) である。

- RBD キャッシュが無効になっている。

手順

PWL キャッシュを有効にします。

ホストレベルで、

ceph config setコマンドを使用します。構文

ceph config set client rbd_persistent_cache_mode CACHE_MODE ceph config set client rbd_plugins pwl_cache

ceph config set client rbd_persistent_cache_mode CACHE_MODE ceph config set client rbd_plugins pwl_cacheCopy to Clipboard Copied! Toggle word wrap Toggle overflow CACHE_MODE は

rwlまたはssdに置き換えます。例

[ceph: root@host01 /]# ceph config set client rbd_persistent_cache_mode ssd [ceph: root@host01 /]# ceph config set client rbd_plugins pwl_cache

[ceph: root@host01 /]# ceph config set client rbd_persistent_cache_mode ssd [ceph: root@host01 /]# ceph config set client rbd_plugins pwl_cacheCopy to Clipboard Copied! Toggle word wrap Toggle overflow プールレベルで、

rbd config pool setコマンドを使用します。構文

rbd config pool set POOL_NAME rbd_persistent_cache_mode CACHE_MODE rbd config pool set POOL_NAME rbd_plugins pwl_cache

rbd config pool set POOL_NAME rbd_persistent_cache_mode CACHE_MODE rbd config pool set POOL_NAME rbd_plugins pwl_cacheCopy to Clipboard Copied! Toggle word wrap Toggle overflow CACHE_MODE は

rwlまたはssdに置き換えます。例

[ceph: root@host01 /]# rbd config pool set pool1 rbd_persistent_cache_mode ssd [ceph: root@host01 /]# rbd config pool set pool1 rbd_plugins pwl_cache

[ceph: root@host01 /]# rbd config pool set pool1 rbd_persistent_cache_mode ssd [ceph: root@host01 /]# rbd config pool set pool1 rbd_plugins pwl_cacheCopy to Clipboard Copied! Toggle word wrap Toggle overflow イメージレベルで、

rbd config image setコマンドを使用します。構文

rbd config image set POOL_NAME/IMAGE_NAME rbd_persistent_cache_mode CACHE_MODE rbd config image set POOL_NAME/IMAGE_NAME rbd_plugins pwl_cache

rbd config image set POOL_NAME/IMAGE_NAME rbd_persistent_cache_mode CACHE_MODE rbd config image set POOL_NAME/IMAGE_NAME rbd_plugins pwl_cacheCopy to Clipboard Copied! Toggle word wrap Toggle overflow CACHE_MODE は

rwlまたはssdに置き換えます。例

[ceph: root@host01 /]# rbd config image set pool1/image1 rbd_persistent_cache_mode ssd [ceph: root@host01 /]# rbd config image set pool1/image1 rbd_plugins pwl_cache

[ceph: root@host01 /]# rbd config image set pool1/image1 rbd_persistent_cache_mode ssd [ceph: root@host01 /]# rbd config image set pool1/image1 rbd_plugins pwl_cacheCopy to Clipboard Copied! Toggle word wrap Toggle overflow

必要に応じて、ホスト、プール、またはイメージレベルで追加の RBD オプションを設定します。

構文

rbd_persistent_cache_mode CACHE_MODE rbd_plugins pwl_cache rbd_persistent_cache_path /PATH_TO_CACHE_DIRECTORY rbd_persistent_cache_size PERSISTENT_CACHE_SIZE

rbd_persistent_cache_mode CACHE_MODE rbd_plugins pwl_cache rbd_persistent_cache_path /PATH_TO_CACHE_DIRECTORY1 rbd_persistent_cache_size PERSISTENT_CACHE_SIZE2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- 1

rbd_persistent_cache_path: パフォーマンスの低下を回避するためにrwlモードを使用する際に、DAX(ダイレクトアクセス) が有効にされている必要のあるデータをキャッシュするファイルフォルダー。- 2

rbd_persistent_cache_size: イメージごとのキャッシュサイズ。最小キャッシュサイズは 1 GB です。キャッシュサイズが大きいほど、パフォーマンスが向上します。rwlモードの追加 RBD オプションの設定:例

rbd_cache false rbd_persistent_cache_mode rwl rbd_plugins pwl_cache rbd_persistent_cache_path /mnt/pmem/cache/ rbd_persistent_cache_size 1073741824

rbd_cache false rbd_persistent_cache_mode rwl rbd_plugins pwl_cache rbd_persistent_cache_path /mnt/pmem/cache/ rbd_persistent_cache_size 1073741824Copy to Clipboard Copied! Toggle word wrap Toggle overflow ssdモードの追加 RBD オプションの設定:例

rbd_cache false rbd_persistent_cache_mode ssd rbd_plugins pwl_cache rbd_persistent_cache_path /mnt/nvme/cache rbd_persistent_cache_size 1073741824

rbd_cache false rbd_persistent_cache_mode ssd rbd_plugins pwl_cache rbd_persistent_cache_path /mnt/nvme/cache rbd_persistent_cache_size 1073741824Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.19. 永続的な書き込みログキャッシュのステータス確認

永続的な書き込みログ (PWL) キャッシュのステータスを確認できます。キャッシュは、排他的ロックの取得時に使用され、排他的ロックの解放時に永続的な書き込みログキャッシュが終了します。キャッシュのステータスには、キャッシュサイズ、場所、タイプ、およびその他のキャッシュ関連情報に関する情報が表示されます。キャッシュの開放および終了時に、キャッシュステータスが更新されます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- monitor ノードへのルートレベルのアクセス。

- PWL キャッシュが有効になっている実行中のプロセス。

手順

PWL キャッシュスのテータスを表示します。

構文

rbd status POOL_NAME/IMAGE_NAME

rbd status POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.20. 永続的な書き込みログキャッシュのフラッシュ

永続的な書き込みログ (PWL) キャッシュを破棄する前に、rbd コマンドを使用して、persistent-cache flush、プール名、およびイメージ名を指定して、キャッシュファイルをフラッシュできます。flush コマンドは、キャッシュファイルを OSD に明示的に書き戻すことができます。キャッシュの中断が発生した場合、またはアプリケーションが予期せず終了した場合、キャッシュ内のすべてのエントリーが OSD にフラッシュされるため、データを手動でフラッシュしてからキャッシュを 無効 にすることができます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- monitor ノードへのルートレベルのアクセス。

- PWL キャッシュが有効である。

手順

PWL キャッシュをフラッシュします。

構文

rbd persistent-cache flush POOL_NAME/IMAGE_NAME

rbd persistent-cache flush POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# rbd persistent-cache flush pool1/image1

[ceph: root@host01 /]# rbd persistent-cache flush pool1/image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.21. 永続的な書き込みログキャッシュの破棄

キャッシュのデータの有効期限が切れている場合など、永続的な書き込みログ (PWL) キャッシュを手動で破棄する必要がある場合があります。rbd image-cache invalidate コマンドを使用すると、イメージのキャッシュファイルを破棄することができます。このコマンドは、指定されたイメージのキャッシュメタデータを削除し、キャッシュ機能を無効にし、ローカルキャッシュファイルが存在する場合は削除します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- monitor ノードへのルートレベルのアクセス。

- PWL キャッシュが有効である。

手順

PWL キャッシュを破棄します。

構文

rbd persistent-cache invalidate POOL_NAME/IMAGE_NAME

rbd persistent-cache invalidate POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# rbd persistent-cache invalidate pool1/image1

[ceph: root@host01 /]# rbd persistent-cache invalidate pool1/image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.22. コマンドラインインターフェイスを使用した Ceph ブロックデバイスのパフォーマンスの監視

Red Hat Ceph Storage 4.1 以降、パフォーマンスメトリック収集フレームワークは、Ceph OSD および Manager コンポーネントに統合されます。このフレームワークには、他の Ceph Block Device のパフォーマンス監視ソリューションの構築時にパフォーマンスメトリックを生成して処理するための手段が含まれます。

新しい Ceph Manager モジュール rbd_support は、有効になっている場合にパフォーマンスメトリックを集約します。rbd コマンドには、iotop と iostat の新しい 2 つのアクションがあります。

これらのアクションの初回使用じには、データフィールドの設定に約 30 秒かかります。

前提条件

- Ceph Monitor ノードへのユーザーレベルのアクセス。

手順

rbd_supportCeph Manager モジュールが有効であることを確認します。例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow "iotop" スタイルのイメージを表示するには、以下のコマンドを実行します。

例

rbd perf image iotop

[user@mon ~]$ rbd perf image iotopCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記ops、read-ops、write-bytes、read-bytes、write-latency、および read-latency の列は、右と左矢印キーを使用して動的にソートできます。

"iostat" スタイルのイメージを表示するには、以下を実行します。

例

rbd perf image iostat

[user@mon ~]$ rbd perf image iostatCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記このコマンドは JSON または XML 形式で出力でき、他のコマンドラインツールを使用してソートできます。

第3章 イメージのライブマイグレーション

ストレージ管理者は、RBD イメージのライブマイグレーションを、異なるプール間で行うことも、同じストレージクラスター内の同じプールで行うことも可能です。

異なるイメージ形式やレイアウトの間や、外部データソースからも移行することができます。ライブマイグレーションが開始されると、ソースイメージは宛先イメージにディープコピーされ、可能な限りデータのスパース割り当てを維持しつつ、すべてのスナップショット履歴をプルします。

暗号化を含むイメージはライブマイグレーションをサポートします。

現時点では、krbd カーネルモジュールはライブ移行に対応していません。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

3.1. ライブマイグレーションプロセス

デフォルトでは、同じストレージクラスターから RBD イメージのライブマイグレーション中には、ソースイメージに読み取り専用のマークが付けられます。すべてのクライアントは、Input/Output (I/O) を新規ターゲットイメージにリダイレクトします。また、このモードは、ソースイメージの親へのリンクを保存してスパース性を保持するか、移行中にイメージをフラット化してソースイメージの親の依存関係を削除することもできます。import-only モードでライブマイグレーションプロセスを使用できます。このモードでは、ソースイメージは変更されません。ターゲットイメージをバックアップファイル、HTTP (s) ファイル、または S3 オブジェクトなどの外部データソースにリンクできます。ライブマイグレーションのコピープロセスは、新規ターゲットイメージの使用中に、バックグラウンドで安全に実行できます。

ライブマイグレーションプロセスは、以下の 3 つのステップで構成されます。

移行の準備: 最初のステップでは、新規ターゲットイメージを作成し、ターゲットイメージをソースイメージにリンクします。import-only モードが設定されていない場合には、ソースイメージはターゲットイメージにもリンクされ、読み取り専用とマークされます。ターゲットイメージ内に初期化されていないデータエクステントの読み取りを試みると、そのソースイメージへの読み込みを内部的にリダイレクトし、ターゲットイメージ内で初期化されていないエクステントへの書き込みが行われ、重複するソースイメージエクステントをターゲットイメージに書き込みます。

Execute Migration: これはバックグラウンドで実行される操作で、ソースイメージからターゲットへの初期化されたすべてのブロックをディープコピーします。クライアントが新規ターゲットイメージをアクティブに使用している場合に、このステップを実行できます。

Finish Migration: バックグラウンドの移行プロセスが完了したら、移行をコミットまたは中止できます。移行をコミットすると、ソースとターゲットイメージ間の相互リンクが削除され、import-only モードで設定されていない場合にはソースイメージが削除されます。移行を中断すると、クロスリンクが削除され、その結果、ターゲットイメージが削除されます。

3.2. フォーマット

現在、Native、qcow、および raw 形式がサポートされています。

native 形式を使用して、Red Hat Ceph Storage クラスター内のネイティブ RBD イメージをソースイメージとして記述することができます。source-spec JSON ドキュメントは以下のようにエンコードされます。

構文

ネイティブ Ceph 操作を使用するため、native フォーマットにはストリームオブジェクトは含まれません。たとえば、イメージの rbd/ns1/image1@snap1 からインポートするには、source-spec を以下のようにエンコードできます。

例

qcow 形式を使用して、QEMU コピーオンライト (QCOW) ブロックデバイスを記述できます。QCOW v1 および v2 形式はいずれも、圧縮、暗号化、バッキングファイル、外部データファイルなどの高度な機能を除き、現在サポートされています。qcow 形式データは、サポート対象のストリームソースにリンクできます。

例

raw 形式を使用して、rbd export –export-format 1 SNAP_SPEC であるシックプロビジョニングされた、raw ブロックデバイスのエクスポートを記述できます。raw 形式データは、サポート対象のストリームソースにリンクできます。

例

snapshots 配列の追加はオプションで、現在、シックプロビジョニングの raw スナップショットのエクスポートのみをサポートします。

3.3. ストリーム

現在、file、HTTP、S3、および NBD ストリームがサポートされています。

ファイルストリーム

ファイル ストリームを使用して、ローカルでアクセス可能な POSIX ファイルソースからインポートできます。

構文

たとえば、/mnt/image.raw にあるファイルから raw 形式のイメージをインポートするには、source-spec JSON ファイルは以下のようになります。

例

HTTP ストリーム

HTTP ストリームを使用して、リモートの HTTP または HTTPS Web サーバーからインポートできます。

構文

たとえば、http://download.ceph.com/image.raw にあるファイルから raw 形式のイメージをインポートするには、source-spec JSON ファイルは以下のようになります。

例

S3 ストリーム

s3 ストリームを使用して、リモート S3 バケットからインポートできます。

構文

たとえば、http://s3.ceph.com/bucket/image.raw にあるファイルから raw 形式のイメージをインポートするには、以下のように source-spec JSON をエンコードします。

例

NBD ストリーム

NBD ストリームを使用して、リモートの NBD エクスポートからインポートできます。

構文

たとえば、nbd://nbd.ceph.com/image.raw にある NBD エクスポートから raw 形式のイメージをインポートする場合、そのソース仕様 JSON は次のようにエンコードされます。

nbd-uri パラメーターは、NBD URI specification に従う必要があります。デフォルトの NBD ポートは 10809 です。

3.4. ライブマイグレーションプロセスの準備

同じ Red Hat Ceph Storage クラスター内にある RBD イメージのデフォルトのライブマイグレーションプロセスを作成できます。rbd migration prepare コマンドでは、rbd create コマンドと同じレイアウトオプションをすべて使用できます。rbd create コマンドでは、イミュータブルイメージのオンディスクレイアウトに変更を加えることができます。ディスク上のレイアウトのみを変更し、元のイメージ名を維持する場合は、migration_target 引数を省略します。ライブマイグレーションを準備する前に、ソースイメージを使用するクライアントをすべて停止する必要があります。読み取り/書き込みモードでイメージが開いている稼働中のクライアントが検出された場合には、prepare の手順は失敗します。prepare 手順が完了したら、新しいターゲットイメージを使用してクライアントを再起動することができます。

ソースイメージを使用してクライアントは再起動できないため、結果は失敗となります。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ブロックデバイスプール 2 つ。

- ブロックデバイスイメージ 1 つ。

クローンされたイメージは、インポート中に暗黙的にフラット化され (--import-only パラメーターを使用)、別の Ceph クラスターに移行されると、ソースクラスター内のすべての親チェーンとの関連付けが解除されます。

手順

オプション: イメージをある Ceph クラスターから別の Ceph クラスターに移行する場合は、両方のクラスターの

ceph.confとceph.client.admin.keyringを共通ノードにコピーします。これにより、クライアントノードが移行のために両方のクラスターにアクセスできるようになります。例

クラスター c1 の

ceph.confおよびceph.client.admin.keyringを共通のノードにコピーします。Copy to Clipboard Copied! Toggle word wrap Toggle overflow クラスター c2 の

ceph.confおよびceph.client.admin.keyringを共通のノードにコピーします。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

ストレージクラスター内でライブマイグレーションを準備します。

構文

rbd migration prepare SOURCE_POOL_NAME/SOURCE_IMAGE_NAME TARGET_POOL_NAME/SOURCE_IMAGE_NAME

rbd migration prepare SOURCE_POOL_NAME/SOURCE_IMAGE_NAME TARGET_POOL_NAME/SOURCE_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@rbd-client /]# rbd migration prepare sourcepool1/sourceimage1 targetpool1/sourceimage1

[ceph: root@rbd-client /]# rbd migration prepare sourcepool1/sourceimage1 targetpool1/sourceimage1Copy to Clipboard Copied! Toggle word wrap Toggle overflow OR

ソースイメージの名前を変更する場合は、以下のコマンドを実行します。

構文

rbd migration prepare SOURCE_POOL_NAME/SOURCE_IMAGE_NAME TARGET_POOL_NAME/NEW_SOURCE_IMAGE_NAME

rbd migration prepare SOURCE_POOL_NAME/SOURCE_IMAGE_NAME TARGET_POOL_NAME/NEW_SOURCE_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@rbd-client /]# rbd migration prepare sourcepool1/sourceimage1 targetpool1/newsourceimage1

[ceph: root@rbd-client /]# rbd migration prepare sourcepool1/sourceimage1 targetpool1/newsourceimage1Copy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

newsourceimage1は名前が変更されたソースイメージです。次のコマンドを使用すると、ライブマイグレーションプロセスの現在の状態を確認できます。

構文

rbd status TARGET_POOL_NAME/SOURCE_IMAGE_NAME

rbd status TARGET_POOL_NAME/SOURCE_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要移行プロセスで、ソースイメージは RBD ゴミ箱に移動され、誤用を回避します。

例

[ceph: root@rbd-client /]# rbd info sourceimage1 rbd: error opening image sourceimage1: (2) No such file or directory

[ceph: root@rbd-client /]# rbd info sourceimage1 rbd: error opening image sourceimage1: (2) No such file or directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@rbd-client /]# rbd trash ls --all sourcepool1 adb429cb769a sourceimage1

[ceph: root@rbd-client /]# rbd trash ls --all sourcepool1 adb429cb769a sourceimage1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5. import-only 移行の準備

--import-only オプションと、--source-spec か、--source-spec-path のオプションを指定して、rbd migration prepare コマンドを実行して、import-only のライブマイグレーションプロセスを開始し、コマンドラインまたはファイルから直接ソースイメージデータにアクセスする方法を記述した JSON ドキュメントを渡します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- バケットおよび S3 オブジェクトが作成されます。

手順

JSON ファイルを作成します。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow import-onlyライブマイグレーションプロセスを準備します。構文

rbd migration prepare --import-only --source-spec-path "JSON_FILE" TARGET_POOL_NAME

rbd migration prepare --import-only --source-spec-path "JSON_FILE" TARGET_POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@rbd-client /]# rbd migration prepare --import-only --source-spec-path "testspec.json" targetpool1

[ceph: root@rbd-client /]# rbd migration prepare --import-only --source-spec-path "testspec.json" targetpool1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記rbd migration prepareコマンドでは、rbd createコマンドと同じイメージオプションをすべて使用できます。import-onlyライブマイグレーションのステータスを確認できます。例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次の例は、Ceph クラスター

c1から Ceph クラスターc2にデータを移行する方法を示しています。例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6. ライブマイグレーションプロセスの実行

ライブマイグレーションを準備したら、イメージブロックをソースイメージからターゲットイメージにコピーする必要があります。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ブロックデバイスプール 2 つ。

- ブロックデバイスイメージ 1 つ。

手順

ライブマイグレーションを実行します。

構文

rbd migration execute TARGET_POOL_NAME/SOURCE_IMAGE_NAME

rbd migration execute TARGET_POOL_NAME/SOURCE_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@rbd-client /]# rbd migration execute targetpool1/sourceimage1 Image migration: 100% complete...done.

[ceph: root@rbd-client /]# rbd migration execute targetpool1/sourceimage1 Image migration: 100% complete...done.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 移行ブロックのディープコピーの進捗に関するフィードバックを確認できます。

構文

rbd status TARGET_POOL_NAME/SOURCE_IMAGE_NAME

rbd status TARGET_POOL_NAME/SOURCE_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.7. ライブマイグレーションプロセスのコミット

ライブマイグレーションで、ソースイメージからターゲットイメージへのディープコピーを完了したら、移行をコミットできます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ブロックデバイスプール 2 つ。

- ブロックデバイスイメージ 1 つ。

手順

ディープコピーが完了したら、移行をコミットします。

構文

rbd migration commit TARGET_POOL_NAME/SOURCE_IMAGE_NAME

rbd migration commit TARGET_POOL_NAME/SOURCE_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@rbd-client /]# rbd migration commit targetpool1/sourceimage1 Commit image migration: 100% complete...done.

[ceph: root@rbd-client /]# rbd migration commit targetpool1/sourceimage1 Commit image migration: 100% complete...done.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ライブマイグレーションをコミットすると、ソースとターゲットイメージ間のクロスリンクが削除され、ソースプールからソースイメージも削除されます。

例

[ceph: root@rbd-client /]# rbd trash list --all sourcepool1

[ceph: root@rbd-client /]# rbd trash list --all sourcepool13.8. ライブマイグレーションプロセスの中断

ライブマイグレーションプロセスは、元に戻すことができます。ライブマイグレーションを中断すると、準備と実行の手順を元に戻します。

ライブマイグレーションがコミットされていない場合に限り、中止できます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ブロックデバイスプール 2 つ。

- ブロックデバイスイメージ 1 つ。

手順

ライブマイグレーションプロセスを中断します。

構文

rbd migration abort TARGET_POOL_NAME/SOURCE_IMAGE_NAME

rbd migration abort TARGET_POOL_NAME/SOURCE_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@rbd-client /]# rbd migration abort targetpool1/sourceimage1 Abort image migration: 100% complete...done.

[ceph: root@rbd-client /]# rbd migration abort targetpool1/sourceimage1 Abort image migration: 100% complete...done.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ライブマイグレーションプロセスを中断すると、ターゲットイメージが削除され、元のソースイメージへのアクセスがソースプールで復元されます。

例

[ceph: root@rbd-client /]# rbd ls sourcepool1 sourceimage1

[ceph: root@rbd-client /]# rbd ls sourcepool1

sourceimage1第4章 イメージの暗号化

ストレージ管理者は、特定の RBD イメージの暗号化に使用されるシークレットキーを設定できます。イメージレベルの暗号化は、RBD クライアントによって内部に処理されます。

krbd モジュールはイメージレベルの暗号化に対応していません。

dm-crypt または QEMU などの外部ツールを使用して、RBD イメージを暗号化できます。

前提条件

- Red Hat Ceph Storage 8 クラスターが実行されている。

-

ルートレベルのパーミッション。

4.1. 暗号化形式

RBD イメージは、デフォルトでは暗号化されません。RBD イメージは、サポート対象の暗号化形式の 1 つにフォーマットすることで暗号化できます。フォーマット操作を行うと、暗号化メタデータを RBD イメージに永続化します。暗号化メタデータには、暗号化形式、バージョン、暗号アルゴリズム、モードの仕様などの情報や、暗号化キーのセキュリティー保護に使用する情報が含まれます。

暗号化鍵は、ユーザーが保存するシークレット (パスフレーズ) で保護されますが、RBD イメージには永続データとして保存されません。暗号化形式の操作では、暗号化形式、暗号アルゴリズム、およびモードの仕様、パスフレーズの指定が必要になります。暗号化メタデータは RBD イメージに保存されます。現在、raw イメージの起動時に書き込まれる暗号化ヘッダーとして保存されます。つまり、暗号化されたイメージの有効なイメージサイズは、raw イメージのサイズよりも小さくなります。

明示的に (再) フォーマットされない限り、暗号化されたイメージのクローンは、同じ形式とシークレットを使用して本質的に暗号化されます。

フォーマット前の RBD イメージへの書き込みデータはいずれも、ストレージリソースを引き続き使用している場合でも、読み取りできなくなる可能性があります。ジャーナル機能が有効になっている RBD イメージは、暗号化できません。

4.2. 暗号化ロード

デフォルトでは、すべての RBD API は、暗号化されていない RBD イメージと同じように、暗号化 RBD イメージを処理します。イメージ内にある raw データはどこにある場合でも読み取りまたは書き込みが可能です。Raw データをイメージに書き込むと、暗号化形式の整合性が確保できなくなる可能性があります。たとえば、raw データは、イメージの最初にある暗号化メタデータを上書きする可能性があります。暗号化された RBD イメージで暗号化された Input/Output (I/O) またはメンテナンス操作を安全に実行するには、イメージを開いてからすぐに、追加の暗号化ロード操作を適用する必要があります。

暗号化ロード操作では、暗号化形式と、イメージ自体の暗号化キーのロックを解除するためのパスフレーズと、明示的にフォーマットされた各先祖イメージを指定する必要があります。開いた RBD イメージの I/O はすべて、クローン作成された RBD イメージ用に暗号化または復号化されます (親イメージの IO を含む)。暗号化キーは、イメージを終了するまで RBD クライアントによってメモリーに保存されます。

暗号化が RBD イメージに読み込まれたら、他の暗号化ロードやフォーマットの操作は適用できません。さらに、開いているイメージコンテキストを使用して RBD イメージサイズと親のオーバーラップを取得する API コールは、それぞれ有効イメージサイズと有効な親のオーバーラップを返します。rbd-nbd を介して RBD イメージをブロックデバイスとしてマッピングするときに、暗号化が自動的に読み込まれます。

開いているイメージコンテキストを使用してイメージサイズと親のオーバーラップを取得する API コールは、有効なイメージサイズと有効な親のオーバーラップを返します。

暗号化されたイメージのクローンが明示的にフォーマットされた場合、親スナップショットから親データをコピーする際にクローンイメージのフォーマットに従って親データを再暗号化する必要があるため、クローン作成されたイメージのフラット化または縮小は透過的でなくなります。フラット化操作を実行する前に暗号化がロードされていないと、クローン作成されたイメージで以前アクセス可能だった親データが読み取れなくなる可能性があります。

暗号化されたイメージのクローンが明示的にフォーマットされた場合、クローン作成されたイメージを縮小する操作は透過的でなくなります。これは、クローン作成されたイメージにスナップショットが含まれていたり、クローン作成されたイメージがオブジェクトサイズに合わないサイズに縮小されていたりするようなシナリオでは、フラット化と同様に、親スナップショットから一部のデータをコピーするアクションが発生するためです。縮小操作を実行する前に暗号化がロードされていないと、クローン作成されたイメージで以前アクセス可能だった親データが読み取れなくなる可能性があります。

4.3. サポート対象の形式

LUKS (Linux Unified Key Setup) 1 と 2 の両方がサポートされます。データレイアウトは、LUKS 仕様に完全に準拠しています。dm-crypt または QEMU などの外部の LUKS 互換ツールは、暗号化された RBD イメージ上で、暗号化された Input/Output (I/O) を安全に実行できます。さらに、raw LUKS データを RBD イメージにコピーして、外部ツールが作成した既存の LUKS イメージをインポートすることもできます。

現在、Advanced Encryption Standards (AES) 128 および 256 暗号化アルゴリズムのみがサポートされています。暗号化モードで唯一サポートされているのは現時点では、xts-plain64 のみです。

LUKS 形式を使用するには、以下のコマンドで RBD イメージをフォーマットします。

passphrase.txt という名前のファイルを作成し、パスフレーズを入力する必要があります。パスフレーズをランダムに生成することができます。これには NULL 文字が含まれる可能性があります。パスフレーズの末尾が改行文字の場合、その改行文字は削除されます。

構文

rbd encryption format POOL_NAME/LUKS_IMAGE luks1|luks2 PASSPHRASE_FILE

rbd encryption format POOL_NAME/LUKS_IMAGE luks1|luks2 PASSPHRASE_FILE例

[ceph: root@host01 /]# rbd encryption format pool1/luksimage1 luks1 passphrase.bin

[ceph: root@host01 /]# rbd encryption format pool1/luksimage1 luks1 passphrase.bin

luks1 または luks の暗号化形式のいずれかを選択できます。

暗号化形式の操作では LUKS ヘッダーを生成し、RBD イメージの最初に作成します。キースロットが 1 つ、ヘッダーに追加されます。キースロットには無作為に生成される暗号鍵が格納され、このキースロットはパスフレーズファイルから読み込むパスフレーズで保護されます。デフォルトでは、xts-plain64 モードの AES-256 (現在の推奨モード) および他の LUKS ツールのデフォルトが使用されます。現在、別のパスフレーズの追加または削除はネイティブにはサポートされていませんが、cryptsetup などの LUKS ツールを使用して実現できます。LUKS ヘッダーのサイズは、LUKS で最大 136MiB によって異なりますが、通常最大 16MiB です (インストールされている libcryptsetup のバージョンにより異なる)。暗号化フォーマットは、イメージオブジェクトサイズに合わせてデータオフセットを設定し、パフォーマンスを最適化します。たとえば、8MiB オブジェクトサイズで設定されたイメージを使用する場合には、オーバーヘッドが最低でも 8MiB 必要です。

LUKS1 では、最小暗号化ユニットであるセクターが 512 バイトに固定されています。LUKS2 はサイズの大きいセクターに対応しており、デフォルトのセクターサイズは最大 4KiB に設定され、パフォーマンスの向上を図ります。セクターよりも小さい書き込み、またはセクターの開始位置が揃っていない書き込みは、クライアント上で保護された read-modify-write チェーンをトリガーします。この際、レイテンシーのペナルティーが大きくなります。書き込みのバッチが整列されていない場合には、I/O 競合が発生し、さらにパフォーマンスが低下する可能性があります。Red Hat は、受信書き込みが LUKS セクターに合わせて確保できない場合に、RBD 暗号化の使用を回避することを推奨します。

LUKS 暗号化イメージをマッピングするには、次のコマンドを実行します。

構文

rbd device map -t nbd -o encryption-format=luks1|luks2,encryption-passphrase-file=passphrase.txt POOL_NAME/LUKS_IMAGE

rbd device map -t nbd -o encryption-format=luks1|luks2,encryption-passphrase-file=passphrase.txt POOL_NAME/LUKS_IMAGE例

[ceph: root@host01 /]# rbd device map -t nbd -o encryption-format=luks1,encryption-passphrase-file=passphrase.txt pool1/luksimage1

[ceph: root@host01 /]# rbd device map -t nbd -o encryption-format=luks1,encryption-passphrase-file=passphrase.txt pool1/luksimage1

luks1 または luks2 の暗号化形式のいずれかを選択できます。

セキュリティー上の理由から、暗号化フォーマットと暗号化ロード操作は CPU に負荷がかかるので、完了するまでに数秒かかることがあります。I/O が暗号化されている場合には、AES-NI が有効になっていると、マイクロ秒単位のレイテンシーが追加され、CPU 使用率が若干増加する可能性があります。

4.4. イメージおよびクローンへの暗号化形式の追加

階層化されたクライアント側の暗号化がサポートされています。クローン作成されたイメージは、親イメージとは異なる独自の形式とパスフレーズで暗号化できます。

rbd encryption format コマンドを使用して、暗号化形式をイメージおよびクローンに追加します。LUKS2 形式のイメージを使用すると、LUKS2 形式のクローンと LUKS1 形式のクローンの両方を作成できます。

前提条件

- ブロックデバイス (RBD) が設定された実行中の Red Hat Ceph Storage クラスター。

- ノードへのルートレベルのアクセス。

手順

LUKS2 形式のイメージを作成します。

構文

rbd create --size SIZE POOL_NAME/LUKS_IMAGE rbd encryption format POOL_NAME/LUKS_IMAGE luks1|luks2 PASSPHRASE_FILE rbd resize --size 50G --encryption-passphrase-file PASSPHRASE_FILE POOL_NAME/LUKS_IMAGE

rbd create --size SIZE POOL_NAME/LUKS_IMAGE rbd encryption format POOL_NAME/LUKS_IMAGE luks1|luks2 PASSPHRASE_FILE rbd resize --size 50G --encryption-passphrase-file PASSPHRASE_FILE POOL_NAME/LUKS_IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# rbd create --size 50G mypool/myimage [ceph: root@host01 /]# rbd encryption format mypool/myimage luks2 passphrase.txt [ceph: root@host01 /]# rbd resize --size 50G --encryption-passphrase-file passphrase.txt mypool/myimage

[ceph: root@host01 /]# rbd create --size 50G mypool/myimage [ceph: root@host01 /]# rbd encryption format mypool/myimage luks2 passphrase.txt [ceph: root@host01 /]# rbd resize --size 50G --encryption-passphrase-file passphrase.txt mypool/myimageCopy to Clipboard Copied! Toggle word wrap Toggle overflow rbd resizeコマンドは、イメージを拡張して LUKS2 ヘッダーに関連するオーバーヘッドを補います。LUKS2 形式のイメージを使用して、同じ有効サイズの LUKS2 形式のクローンを作成します。

構文

rbd snap create POOL_NAME/IMAGE_NAME@SNAP_NAME rbd snap protect POOL_NAME/IMAGE_NAME@SNAP_NAME rbd clone POOL_NAME/IMAGE_NAME@SNAP_NAME POOL_NAME/CLONE_NAME rbd encryption format POOL_NAME/CLONE_NAME luks1 CLONE_PASSPHRASE_FILE

rbd snap create POOL_NAME/IMAGE_NAME@SNAP_NAME rbd snap protect POOL_NAME/IMAGE_NAME@SNAP_NAME rbd clone POOL_NAME/IMAGE_NAME@SNAP_NAME POOL_NAME/CLONE_NAME rbd encryption format POOL_NAME/CLONE_NAME luks1 CLONE_PASSPHRASE_FILECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# rbd snap create mypool/myimage@snap [ceph: root@host01 /]# rbd snap protect mypool/myimage@snap [ceph: root@host01 /]# rbd clone mypool/myimage@snap mypool/myclone [ceph: root@host01 /]# rbd encryption format mypool/myclone luks1 clone-passphrase.bin

[ceph: root@host01 /]# rbd snap create mypool/myimage@snap [ceph: root@host01 /]# rbd snap protect mypool/myimage@snap [ceph: root@host01 /]# rbd clone mypool/myimage@snap mypool/myclone [ceph: root@host01 /]# rbd encryption format mypool/myclone luks1 clone-passphrase.binCopy to Clipboard Copied! Toggle word wrap Toggle overflow LUKS2 形式のイメージを使用して、同じ有効サイズの LUKS1 形式のクローンを作成します。

構文

rbd snap create POOL_NAME/IMAGE_NAME@SNAP_NAME rbd snap protect POOL_NAME/IMAGE_NAME@SNAP_NAME rbd clone POOL_NAME/IMAGE_NAME@SNAP_NAME POOL_NAME/CLONE_NAME rbd encryption format POOL_NAME/CLONE_NAME luks1 CLONE_PASSPHRASE_FILE rbd resize --size SIZE --allow-shrink --encryption-passphrase-file CLONE_PASSPHRASE_FILE --encryption-passphrase-file PASSPHRASE_FILE POOL_NAME/CLONE_NAME

rbd snap create POOL_NAME/IMAGE_NAME@SNAP_NAME rbd snap protect POOL_NAME/IMAGE_NAME@SNAP_NAME rbd clone POOL_NAME/IMAGE_NAME@SNAP_NAME POOL_NAME/CLONE_NAME rbd encryption format POOL_NAME/CLONE_NAME luks1 CLONE_PASSPHRASE_FILE rbd resize --size SIZE --allow-shrink --encryption-passphrase-file CLONE_PASSPHRASE_FILE --encryption-passphrase-file PASSPHRASE_FILE POOL_NAME/CLONE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# rbd snap create mypool/myimage@snap [ceph: root@host01 /]# rbd snap protect mypool/myimage@snap [ceph: root@host01 /]# rbd clone mypool/myimage@snap mypool/myclone [ceph: root@host01 /]# rbd encryption format mypool/myclone luks1 clone-passphrase.bin [ceph: root@host01 /]# rbd resize --size 50G --allow-shrink --encryption-passphrase-file clone-passphrase.bin --encryption-passphrase-file passphrase.bin mypool/myclone

[ceph: root@host01 /]# rbd snap create mypool/myimage@snap [ceph: root@host01 /]# rbd snap protect mypool/myimage@snap [ceph: root@host01 /]# rbd clone mypool/myimage@snap mypool/myclone [ceph: root@host01 /]# rbd encryption format mypool/myclone luks1 clone-passphrase.bin [ceph: root@host01 /]# rbd resize --size 50G --allow-shrink --encryption-passphrase-file clone-passphrase.bin --encryption-passphrase-file passphrase.bin mypool/mycloneCopy to Clipboard Copied! Toggle word wrap Toggle overflow LUKS1 のヘッダーは通常 LUKS2 のヘッダーよりも小さいため、最後の

rbd resizeコマンドにより、クローン作成したイメージを縮小し、不要な余裕領域を取り除きます。LUKS1 形式のイメージを使用して、同じ有効サイズの LUKS2 形式のクローンを作成します。

構文

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow LUKS2 のヘッダーは通常 LUKS1 のヘッダーよりも大きいため、最初の

rbd resizeコマンドにより、親イメージを一時的に拡張し、親スナップショットおよびクローン作成されたイメージに追加領域を予約します。これは、クローン作成されたイメージのすべての親データにアクセスできるようにするために必要です。最後のrbd resizeコマンドは、親イメージを元のサイズに縮小し、未使用の予約領域を取り除きます。親スナップショットとクローン作成されたイメージには影響を与えません。フォーマットされていないイメージにはヘッダーがないため、フォーマットされていないイメージのフォーマットされたクローンの作成にも同様のことが適用されます。

第5章 スナップショットの管理

ストレージ管理者は、Ceph のスナップショット機能を十分に理解している場合には、Red Hat Ceph Storage クラスターに保存されているイメージのスナップショットの管理や、クローン作成に役立ちます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

5.1. Ceph ブロックデバイスのスナップショット

スナップショットは、特定の時点におけるイメージの状態の読み取り専用コピーです。Ceph ブロックデバイスの高度な機能の 1 つとして、イメージのスナップショットを作成して、イメージの状態の履歴を保持できることが挙げられます。Ceph は、スナップショット階層機能もサポートしており、仮想マシンイメージなどのイメージのクローンをすばやく簡単に作成できます。Ceph は、QEMU、libvirt、OpenStack、および CloudStack など、rbd コマンドと、より上層レベルのインターフェイスを使用するブロックデバイススナップショットをサポートします。

I/O の発生中にスナップショットが作成された場合、スナップショットは正確なイメージデータまたは最新のイメージデータを取得できず、マウントできる新規イメージに、スナップショットをクローンする必要がある場合があります。Red Hat は、イメージのスナップショットを作成する前に I/O を停止することを推奨します。イメージにファイルシステムが含まれる場合に、ファイルシステムはスナップショットの作成前に整合性のある状態でなければなりません。I/O を停止するには、fsfreeze コマンドを使用します。仮想マシンの場合には、qemu-guest-agent を使用してスナップショットの作成時にファイルシステムを自動的にフリーズできます。

図5.1 Ceph Block デバイスのスナップショット

関連情報

-

詳細は、

fsfreeze(8)の man ページを参照してください。

5.2. Ceph ユーザーおよびキーリング

cephx が有効な場合には、ユーザー名または ID とユーザーに対応するキーが含まれるキーリングへのパスを指定する必要があります。

cephx はデフォルトで有効化されています。

以下のパラメーターのエントリーを再追加しなくてもいいように、CEPH_ARGS 環境変数を追加することもできます。

構文

rbd --id USER_ID --keyring=/path/to/secret [commands] rbd --name USERNAME --keyring=/path/to/secret [commands]

rbd --id USER_ID --keyring=/path/to/secret [commands]

rbd --name USERNAME --keyring=/path/to/secret [commands]例

rbd --id admin --keyring=/etc/ceph/ceph.keyring [commands] rbd --name client.admin --keyring=/etc/ceph/ceph.keyring [commands]

[root@rbd-client ~]# rbd --id admin --keyring=/etc/ceph/ceph.keyring [commands]

[root@rbd-client ~]# rbd --name client.admin --keyring=/etc/ceph/ceph.keyring [commands]

ユーザーとシークレットを CEPH_ARGS 環境変数に追加して、毎回入力する必要がないようにします。

5.3. ブロックデバイススナップショットの作成

Ceph ブロックデバイスのスナップショットを作成します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

snap createオプション、プール名、およびイメージ名を指定します。方法 1:

構文

rbd --pool POOL_NAME snap create --snap SNAP_NAME IMAGE_NAME

rbd --pool POOL_NAME snap create --snap SNAP_NAME IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool pool1 snap create --snap snap1 image1

[root@rbd-client ~]# rbd --pool pool1 snap create --snap snap1 image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 方法 2:

構文

rbd snap create POOL_NAME/IMAGE_NAME@SNAP_NAME

rbd snap create POOL_NAME/IMAGE_NAME@SNAP_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd snap create pool1/image1@snap1

[root@rbd-client ~]# rbd snap create pool1/image1@snap1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4. ブロックデバイススナップショットのリスト表示

ブロックデバイスのスナップショットをリスト表示します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

プール名とイメージ名を指定します。

構文

rbd --pool POOL_NAME --image IMAGE_NAME snap ls rbd snap ls POOL_NAME/IMAGE_NAME

rbd --pool POOL_NAME --image IMAGE_NAME snap ls rbd snap ls POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool pool1 --image image1 snap ls rbd snap ls pool1/image1

[root@rbd-client ~]# rbd --pool pool1 --image image1 snap ls [root@rbd-client ~]# rbd snap ls pool1/image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.5. ブロックデバイススナップショットのロールバック

ブロックデバイスのスナップショットをロールバックします。

イメージをスナップショットにロールバックすると、イメージの現行バージョンがスナップショットからのデータで上書きされます。ロールバックの実行にかかる時間は、イメージのサイズとともに増加します。スナップショットにイメージを ロールバック するよりも、クローンするほうが短時間ででき、既存の状態戻す方法として推奨の方法です。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

snap rollbackオプション、プール名、イメージ名、および snap 名を指定します。構文

rbd --pool POOL_NAME snap rollback --snap SNAP_NAME IMAGE_NAME rbd snap rollback POOL_NAME/IMAGE_NAME@SNAP_NAME

rbd --pool POOL_NAME snap rollback --snap SNAP_NAME IMAGE_NAME rbd snap rollback POOL_NAME/IMAGE_NAME@SNAP_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool pool1 snap rollback --snap snap1 image1 rbd snap rollback pool1/image1@snap1

[root@rbd-client ~]# rbd --pool pool1 snap rollback --snap snap1 image1 [root@rbd-client ~]# rbd snap rollback pool1/image1@snap1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.6. ブロックデバイススナップショットの削除

Ceph ブロックデバイスのスナップショットを削除します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

ブロックデバイスのスナップショットを削除するには、

snap rmオプション、プール名、イメージ名、およびスナップショット名を指定します。構文

rbd --pool POOL_NAME snap rm --snap SNAP_NAME IMAGE_NAME rbd snap rm POOL_NAME-/IMAGE_NAME@SNAP_NAME

rbd --pool POOL_NAME snap rm --snap SNAP_NAME IMAGE_NAME rbd snap rm POOL_NAME-/IMAGE_NAME@SNAP_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool pool1 snap rm --snap snap2 image1 rbd snap rm pool1/image1@snap1

[root@rbd-client ~]# rbd --pool pool1 snap rm --snap snap2 image1 [root@rbd-client ~]# rbd snap rm pool1/image1@snap1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

イメージにクローンがある場合には、クローン作成されたイメージは、親イメージのスナップショットへの参照を保持します。親イメージのスナップショットを削除するには、最初に子イメージをフラット化する必要があります。

Ceph OSD デーモンはデータを非同期的に削除するため、スナップショットを削除してもディスク領域がすぐに解放されません。

関連情報

- 詳細は、Red Hat Ceph Storage ブロックデバイスガイド の クローンしたイメージのフラット化 を参照してください。

5.7. ブロックデバイススナップショットのパージ

ブロックデバイススナップショットをパージします。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

snap purgeオプションと、特定のプールにイメージ名を指定します。構文

rbd --pool POOL_NAME snap purge IMAGE_NAME rbd snap purge POOL_NAME/IMAGE_NAME

rbd --pool POOL_NAME snap purge IMAGE_NAME rbd snap purge POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool pool1 snap purge image1 rbd snap purge pool1/image1

[root@rbd-client ~]# rbd --pool pool1 snap purge image1 [root@rbd-client ~]# rbd snap purge pool1/image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.8. ブロックデバイススナップショットの名前変更

ブロックデバイスのスナップショットの名前を変更します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

スナップショットの名前を変更するには、以下のコマンドを実行します。

構文

rbd snap rename POOL_NAME/IMAGE_NAME@ORIGINAL_SNAPSHOT_NAME POOL_NAME/IMAGE_NAME@NEW_SNAPSHOT_NAME

rbd snap rename POOL_NAME/IMAGE_NAME@ORIGINAL_SNAPSHOT_NAME POOL_NAME/IMAGE_NAME@NEW_SNAPSHOT_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd snap rename data/dataset@snap1 data/dataset@snap2

[root@rbd-client ~]# rbd snap rename data/dataset@snap1 data/dataset@snap2Copy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、

dataプールにあるデータセットイメージのsnap1スナップショットの名前がsnap2に変更されます。-

rbd help snap renameコマンドを実行して、スナップショットの名前変更に関する追加情報を表示します。

5.9. Ceph ブロックデバイスの階層化

Ceph は、ブロックデバイススナップショットの多数のコピーオンライト (COW) またはコピーオンリード (COR) のクローンを作成する機能をサポートしています。スナップショットの階層化により、Ceph ブロックデバイスクライアントはイメージを非常に迅速に作成できます。たとえば、Linux 仮想マシンで書き込んだブロックデバイスイメージを作成できます。次に、イメージのスナップショットを作成して、スナップショットを保護し、必要な数のクローンを作成します。スナップショットは読み取り専用であるため、スナップショットのクローンを作成するとセマンティクスが簡素化され、クローンの作成時間を短縮できます。

図5.2 Ceph Block デバイスの階層化

親 および 子 という用語は、Ceph ブロックデバイスのスナップショット (親)、およびスナップショットからクローン作成された対応のイメージ (子) を意味します。以下のコマンドラインを使用する場合に、これらの用語が重要です。

クローン作成された各イメージ (子) は、親イメージへの参照を保存し、クローン作成されたイメージで親スナップショットを開き、読み取ることができるようになります。この参照は、クローンが フラット化 (スナップショットからの情報が完全にクローンにコピー) されると、削除されます。

スナップショットのクローン作成は、他の Ceph ブロックデバイスイメージのように動作します。クローン作成されたイメージを読み取り、書き込み、クローンし、サイズを変更できます。クローン作成されたイメージには、特別な制限はありません。ただし、スナップショットのクローンはスナップショットを参照するので、クローンを作成する前にスナップショットを保護する 必要があります。

スナップショットのクローンは、コピーオンライト (COW) またはコピーオンリード (COR) のいずれかです。クローンではコピーオンライト (COW) は常に有効で、コピーオンリード (COR) は明示的に有効化する必要があります。コピーオンライト (COW) は、クローン内の未割り当てのオブジェクトへの書き込み時に、親からクローンにデータをコピーします。コピーオンリード (COR) は、クローン内の未割り当てのオブジェクトから読み取る時に、親からクローンにデータをコピーします。クローンからデータの読み取りは、オブジェクトがクローンに存在しない場合、親からのデータのみを読み取ります。RADOS ブロックデバイスは、サイズの大きいイメージを複数のオブジェクトに分割します。デフォルトは 4 MB に設定され、すべてのコピーオンライト (COW) およびすべてのコピーオンリード (COR) 操作が完全なオブジェクトで行われます。つまり、クローンに 1 バイトが書き込まれると、4 MB オブジェクトが親から読み取られ、まだ以前の COW/COR 操作から宛先オブジェクトがクローンに存在しない場合には、クローンに書き込まれます。

コピーオンリード (COR) が有効になっているかどうか。クローンから下層にあるオブジェクトを読み取ることができない場合には、親に再ルーティングされます。実質的に親の数に制限が特にないため、クローンのクローンを作成できます。これは、オブジェクトが見つかるまで、またはベースの親イメージに到達するまで、この再ルーティングが続行されます。コピーオンリード (COR) が有効になっている場合には、クローンから直接読み取ることができない場合には、親からすべてのオブジェクトを読み取り、そのデータをクローンに書き込むことで、今後、親から読み取る必要なく、同じエクステントの読み取りがクローン自体で行われるようにします。

これは基本的に、オンデマンドのオブジェクトごとのフラット化操作です。これは、クローンが親から離れた高遅延接続の場所 (別の地理的場所の別のプールにある親など) にある場合に特に便利です。コピーオンリード (COR) では、読み取りのならし遅延が短縮されます。最初の数回読み取りは、親から追加のデータが読み取られるため、レイテンシーが高くなっています。たとえば、クローンから 1 バイトを読み取る場合に、4 MB を親から読み取り、クローンに書き込みする必要がありますが、それ以降はクローン自体からすべての読み取りが行われます。

スナップショットからコピーオンリード (COR) のクローンを作成するには、ceph.conf ファイルの [global] セクションまたは [client] セクションに rbd_clone_copy_on_read = true を追加してこの機能を明示的に有効にする必要があります。

関連情報

-

フラット化の詳細は、Red Hat Ceph Storage ブロックデバイスガイド の クローンしたイメージのフラット化 セクションを参照してください。

5.10. ブロックデバイススナップショットの保護

親スナップショットのクローン作成は、親スナップショットにアクセスします。ユーザーが親のスナップショットを誤って削除した場合に、クローンはすべて破損します。

set-require-min-compat-client パラメーターは、Ceph の mimic バージョン以上に設定できます。

例

ceph osd set-require-min-compat-client mimic

ceph osd set-require-min-compat-client mimicこれにより、デフォルトでクローン v2 が作成されます。ただし、mimic よりも古いクライアントは、これらのブロックデバイスイメージにアクセスできません。

クローン v2 では、スナップショットの保護は必要ありません。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

以下のコマンドで

POOL_NAME、IMAGE_NAME、およびSNAP_SHOT_NAMEを指定します。構文

rbd --pool POOL_NAME snap protect --image IMAGE_NAME --snap SNAPSHOT_NAME rbd snap protect POOL_NAME/IMAGE_NAME@SNAPSHOT_NAME

rbd --pool POOL_NAME snap protect --image IMAGE_NAME --snap SNAPSHOT_NAME rbd snap protect POOL_NAME/IMAGE_NAME@SNAPSHOT_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool pool1 snap protect --image image1 --snap snap1 rbd snap protect pool1/image1@snap1

[root@rbd-client ~]# rbd --pool pool1 snap protect --image image1 --snap snap1 [root@rbd-client ~]# rbd snap protect pool1/image1@snap1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記保護されたスナップショットは削除できません。

5.11. ブロックデバイススナップショットのクローン作成

ブロックデバイスのスナップショットを複製すると、データを重複させずに既存のブロックデバイスのスナップショットの書き込み可能なコピーを効率的に作成できます。

要件に応じて、単一のブロックデバイスのスナップショットまたはグループブロックデバイスのスナップショットを複製できます。

5.11.1. 単一のブロックデバイススナップショットのクローン作成

ブロックデバイスのスナップショットのクローンを作成して、同じプール内または別のプール内に、スナップショットの子イメージ (読み取りまたは書き込みイメージ) を作成します。ユースケースの例として、読み取り専用のイメージおよびスナップショットをプールでテンプレートとして維持し、別のプールで書き込み可能なクローンとして維持します。

クローン v2 では、スナップショットの保護は必要ありません。

前提条件

始める前に、次の前提条件が満たされていることを確認してください。

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへのルートレベルのアクセス。

手順

スナップショットのクローンを作成するには、親プール、スナップショット、子プール、およびイメージ名を指定する必要があります。

構文

rbd clone --pool POOL_NAME --image PARENT_IMAGE --snap SNAP_NAME --dest-pool POOL_NAME --dest CHILD_IMAGE_NAME rbd clone POOL_NAME/PARENT_IMAGE@SNAP_NAME POOL_NAME/CHILD_IMAGE_NAME

rbd clone --pool POOL_NAME --image PARENT_IMAGE --snap SNAP_NAME --dest-pool POOL_NAME --dest CHILD_IMAGE_NAME rbd clone POOL_NAME/PARENT_IMAGE@SNAP_NAME POOL_NAME/CHILD_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd clone --pool pool1 --image image1 --snap snap1 --dest-pool pool1 --dest childimage1 rbd clone pool1/image1@snap1 pool1/childimage1

[root@rbd-client ~]# rbd clone --pool pool1 --image image1 --snap snap1 --dest-pool pool1 --dest childimage1 [root@rbd-client ~]# rbd clone pool1/image1@snap1 pool1/childimage1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.11.2. ブロックデバイスグループのスナップショットのクローン作成

rbd clone コマンドの最新の --snap-id オプションを使用して rbd group snap create コマンドで作成されたグループスナップショットから新しいグループを複製できます。

前提条件

始める前に、次の前提条件が満たされていることを確認してください。

- Red Hat Storage Ceph クラスターを実行している。

- ノードへの root レベルのアクセス。

- グループのスナップショット。

グループスナップショットからのクローン作成は、clone v2 --rbd-default-clone-format 2 でのみサポートされます。

例

] rbd clone --snap-id 4 pool1/image1 pool1/i1clone1 --rbd-default-clone-format 2

[root@rbd-client]# ] rbd clone --snap-id 4 pool1/image1 pool1/i1clone1 --rbd-default-clone-format 2手順

グループスナップショットのスナップ ID を取得します。

構文

rbd snap ls --all POOL_NAME/PARENT_IMAGE_NAME

rbd snap ls --all POOL_NAME/PARENT_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 次の例では、

SNAPIDが4とNAMESPACEがグループとして一覧表示されているgroupスナップショットがあります。例

[root@rbd-client] # rbd snap ls --all pool1/image1 SNAPID NAME SIZE PROTECTED TIMESTAMP NAMESPACE 3 snap1 10 GiB yes Thu Jul 25 06:21:33 2024 user 4 .group.2_39d 10 GiB Wed Jul 31 02:28:49 2024 group (pool1/group1@p1g1snap1)

[root@rbd-client] # rbd snap ls --all pool1/image1 SNAPID NAME SIZE PROTECTED TIMESTAMP NAMESPACE 3 snap1 10 GiB yes Thu Jul 25 06:21:33 2024 user 4 .group.2_39d 10 GiB Wed Jul 31 02:28:49 2024 group (pool1/group1@p1g1snap1)Copy to Clipboard Copied! Toggle word wrap Toggle overflow --snap-idオプションを使用して、グループスナップショットのクローンを作成します。構文

rbd clone --snap-id SNAP_ID POOL_NAME/IMAGE_NAME POOL_NAME/CLONE_IMAGE_NAME --rbd-default-clone-format 2

rbd clone --snap-id SNAP_ID POOL_NAME/IMAGE_NAME POOL_NAME/CLONE_IMAGE_NAME --rbd-default-clone-format 2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd clone --snap-id 4 pool1/image1 pool2/clone2 --rbd-default-clone-format 2

[root@rbd-client]# rbd clone --snap-id 4 pool1/image1 pool2/clone2 --rbd-default-clone-format 2Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証手順

rbd lsコマンドを使用して、グループスナップショットのクローンイメージが正常に作成されたことを確認します。例

rbd ls -p pool2

[root@rbd-client]# rbd ls -p pool2 clone2Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.12. ブロックデバイススナップショットの保護解除

スナップショットを削除する前に、そのスナップショットを保護解除する必要があります。さらに、クローンからの参照があるスナップショットは、削除できません。スナップショットを削除する前に、スナップショットの各クローンをフラット化する必要があります。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへの root レベルのアクセス。

手順

以下のコマンドを実行します。

構文

rbd --pool POOL_NAME snap unprotect --image IMAGE_NAME --snap SNAPSHOT_NAME rbd snap unprotect POOL_NAME/IMAGE_NAME@SNAPSHOT_NAME

rbd --pool POOL_NAME snap unprotect --image IMAGE_NAME --snap SNAPSHOT_NAME rbd snap unprotect POOL_NAME/IMAGE_NAME@SNAPSHOT_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool pool1 snap unprotect --image image1 --snap snap1 rbd snap unprotect pool1/image1@snap1

[root@rbd-client ~]# rbd --pool pool1 snap unprotect --image image1 --snap snap1 [root@rbd-client ~]# rbd snap unprotect pool1/image1@snap1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.13. スナップショットの子のリスト表示

スナップショットの子をリスト表示します。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへの root レベルのアクセス。

手順

スナップショットの子をリスト表示するには、以下のコマンドを実行します。

構文

rbd --pool POOL_NAME children --image IMAGE_NAME --snap SNAP_NAME rbd children POOL_NAME/IMAGE_NAME@SNAPSHOT_NAME

rbd --pool POOL_NAME children --image IMAGE_NAME --snap SNAP_NAME rbd children POOL_NAME/IMAGE_NAME@SNAPSHOT_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool pool1 children --image image1 --snap snap1 rbd children pool1/image1@snap1

[root@rbd-client ~]# rbd --pool pool1 children --image image1 --snap snap1 [root@rbd-client ~]# rbd children pool1/image1@snap1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.14. クローンしたイメージのフラット化

クローン作成されたイメージは、親スナップショットへの参照を保持します。親スナップショットへの参照を子クローンから削除すると、実質的に、その情報をスナップショットからクローンにコピーしてイメージを "フラット化" できます。クローンのフラット化にかかる時間は、スナップショットのサイズとともに増加します。フラット化イメージにはスナップショットからのすべての情報が含まれるため、フラット化されるイメージは階層化されたクローンよりも多くのストレージ領域を使用します。

イメージで ディープフラット 機能が有効になっている場合には、イメージのクローンは、デフォルトで親から分離されます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ノードへの root レベルのアクセス。

手順

子イメージに関連付けられた親イメージのスナップショットを削除するには、最初に子イメージをフラット化する必要があります。

構文

rbd --pool POOL_NAME flatten --image IMAGE_NAME rbd flatten POOL_NAME/IMAGE_NAME

rbd --pool POOL_NAME flatten --image IMAGE_NAME rbd flatten POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

rbd --pool pool1 flatten --image childimage1 rbd flatten pool1/childimage1

[root@rbd-client ~]# rbd --pool pool1 flatten --image childimage1 [root@rbd-client ~]# rbd flatten pool1/childimage1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第6章 Ceph ブロックデバイスのミラーリング

ストレージ管理者は、Red Hat Ceph Storage クラスター間でデータイメージをミラーリングして、冗長性向けに別の階層を Ceph ブロックデバイスに追加できます。Ceph ブロックデバイスのミラーリングを理解して使用すると、サイト障害など、データ損失から守ることができます。Ceph ブロックデバイスのミラーリングには、一方向ミラーリングまたは双方向ミラーリングの 2 つの設定があり、プールと個別のイメージにミラーリングを設定できます。

前提条件

- 少なくとも、正常に実行されている Red Hat Ceph Storage クラスター 2 台。

- 2 つのストレージクラスター間のネットワーク接続。

- 各 Red Hat Ceph Storage クラスターの Ceph クライアントノードへのアクセス。

- 管理者レベル権限が割り当てられた CephX ユーザー。

6.1. Ceph ブロックデバイスのミラーリング

RADOS ブロックデバイス (RBD) ミラーリングは、2 つ以上の Ceph Storage クラスター間で Ceph ブロックデバイスイメージを非同期的に複製するプロセスです。RBD ミラーリングは、Ceph Storage クラスターを地理的に異なる場所に配置することで、RBD イメージのリモートコピーを保持し、高可用性と障害復旧を確保するのに役立ちます。

ブロックデバイスのミラーリングに使用されるプライマリープールとセカンダリープールの CRUSH 階層は、容量とパフォーマンスが同様である必要があります。また、ミラーリング中の遅延を回避するために十分なネットワーク帯域幅も必要です。たとえば、ジャーナルベースのミラーリングの場合、プライマリークラスター内のイメージへの平均書き込み速度が X MB/秒である場合、ネットワークは少なくとも N*X スループット (N はミラーリングされたイメージの数) をサポートし、さらに安全のために追加の帯域幅 (Y%) をサポートする必要があります。

rbd-mirror デーモンは、1 つのクラスターのプライマリーイメージから変更を取得し、それを別のクラスターのミラーイメージに書き込むことで同期を処理します。

6.1.1. RBD ミラーリングのモード

RBD ミラーリングには 2 つのモードがあります。

- ジャーナルベースのミラーリング

- このモードでは、RBD ジャーナリングイメージ機能を使用して、まずすべての書き込み操作をジャーナルに記録してからイメージに適用することで、クラスター間でポイントインタイムのクラッシュ整合性のあるレプリケーションを提供します。リモートクラスターはこれらのジャーナルエントリーを再生して、一貫性のある最新のレプリカを維持します。

すべての書き込み操作にはジャーナルとイメージの両方への書き込みが含まれるため、ジャーナリングを有効にすると書き込み待ち時間がほぼ 2 倍になる可能性があります。

- スナップショットベースのミラーリング

- このモードでは、RBD ミラースナップショットを使用して、2 つのスナップショット間で変更されたデータとメタデータのみを識別してコピーすることでイメージを複製します。リモートクラスターはこれらの違いを適用して、一貫性のあるレプリカを維持します。RBD fast-diff イメージ機能は、イメージ全体をスキャンせずに変更されたデータブロックを迅速に識別することで、このプロセスを高速化します。フェイルオーバー中は、スナップショットデルタの完全なセットを同期する必要があります。イメージの一貫性を確保するために、部分的な更新は自動的にロールバックされます。

6.2. Ceph Block Device のミラーリングの設定の概要

rbd-mirror デーモンは、Ceph Storage クラスター 1 台では一方向ミラーリング、Ceph Storage クラスター 2 台ではミラーリング関係に参加する双方向ミラーリングを実行します。

rbd-mirror デーモンは、リモートプライマリーイメージから変更を取得し、プライマリーイメージ以外のローカルイメージにそれらの変更を書き込むことで、別の Ceph Storage クラスターにイメージを同期します。

一方向または双方向レプリケーションのどちらかを使用して RBD ミラーリングを機能させる場合に、いくつかの前提条件があります。

- 同じ名前のプールが両方のストレージクラスターに存在する。

- ジャーナルベースのミラーリングの場合、プールにはミラーリングするジャーナル対応イメージが含まれます。

一方向または双方向レプリケーションでは、rbd-mirror の各インスタンスは他の Ceph Storage クラスターを同時に接続できる必要があります。また、ミラーリングを処理するには、2 つのデータセンターサイト間のネットワークに十分な帯域幅が必要です。

ミラーリングは、ストレージクラスターのミラーリングを使用して、プールごとに設定されます。Ceph は、プールのイメージの種類に応じて、2 つのミラーリングモードをサポートします。

- プールモード

- ジャーナリング機能が有効になっているプール内のイメージはすべてミラーリングされます。

- イメージモード

- プール内の特定のイメージのサブセットのみがミラーリングされます。各イメージのミラーリングを別々に有効にする必要があります。

イメージの変更が可能かどうかは、その状態により異なります。

- プライマリー状態でイメージを変更できます。

- 非プライマリー状態のイメージを変更できません。

イメージでミラーリングが有効になっている場合、イメージは自動的にプライマリーにプロモートされます。以下でプロモートが可能です。

- プールモードでミラーリングを有効にし、ジャーナルベースのイメージに対してのみ暗黙的に有効にします。

- 特定のイメージのミラーリングを明示的に有効にします。

プライマリーイメージをデモートし、プライマリー以外のイメージをプロモートすることができます。

6.2.1. 一方向レプリケーション

一方向ミラーリングは、ストレージクラスター内のプライマリーイメージまたはプールのイメージがセカンダリーのストレージクラスターにレプリケートされることを意味します。一方向ミラーリングは、複数のセカンダリーストレージクラスターへのレプリケーションにも対応します。

セカンダリーストレージクラスターでは、イメージはプライマリー以外のレプリケーションであるため、Ceph クライアントはイメージに書き込むことができません。データがプライマリーストレージクラスターからセカンダリーストレージクラスターにミラーリングされる場合、rbd-mirror はセカンダリーストレージクラスターでのみ実行されます。

一方向のミラーリングを機能させるには、いくつかの前提条件があります。

- 2 つの Red Hat Storage Ceph Storage クラスターがあり、プライマリーストレージクラスターからセカンダリーストレージクラスターにイメージを複製する。

-

セカンダリーストレージクラスターには、クラスターノードの 1 つで実行できる

rbd-mirrorデーモンが含まれている。rbd-mirrorデーモンは、プライマリーストレージクラスターに接続して、イメージをセカンダリーストレージクラスターに同期します。

図6.1 一方向ミラーリング

6.2.2. 双方向レプリケーション

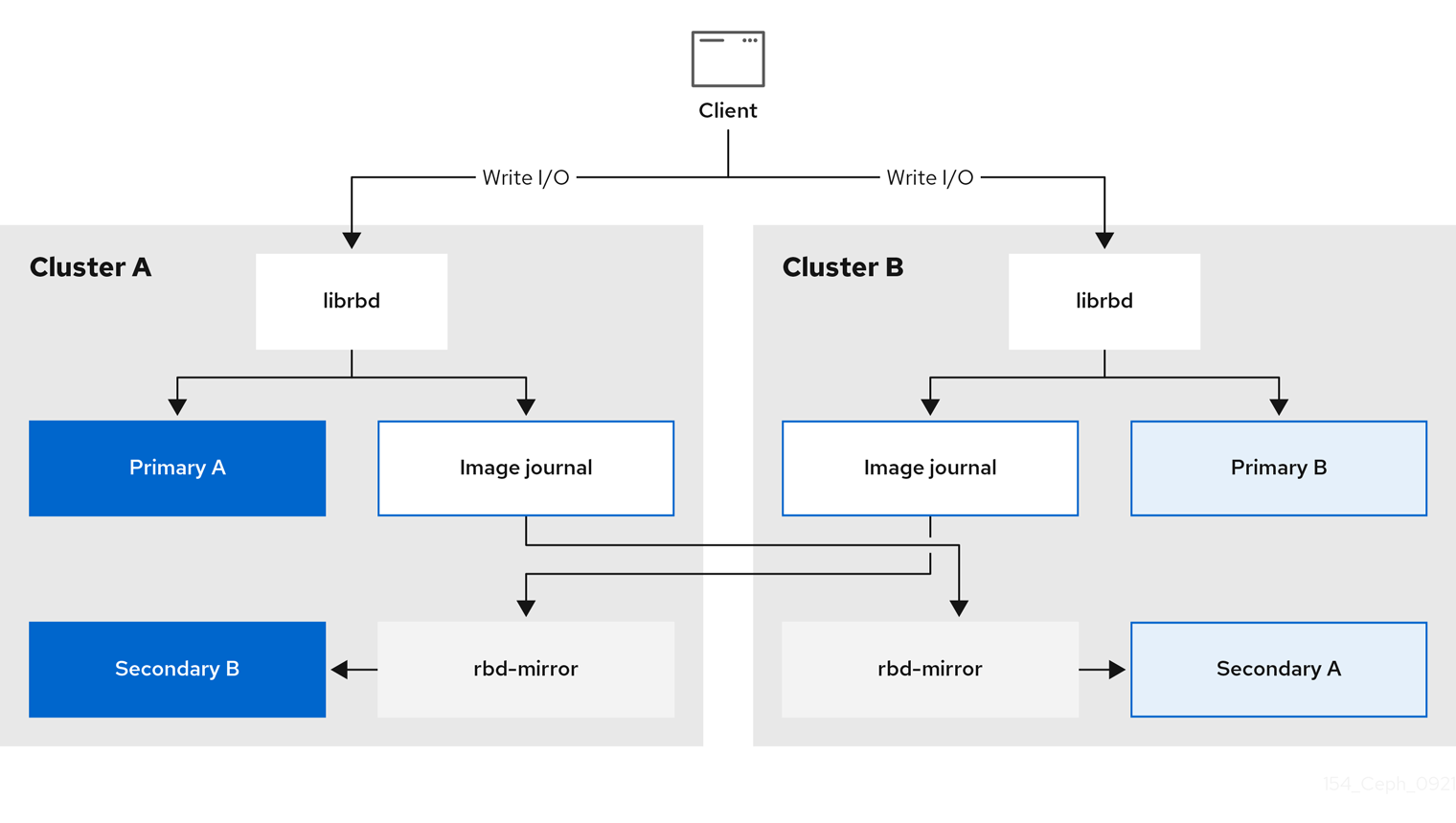

双方向レプリケーションは、プライマリークラスターに rbd-mirror デーモンを追加して、そのクラスターでイメージをデモートし、セカンダリークラスターでプロモートできるようにします。その後、セカンダリークラスターのイメージに対して変更が行われ、セカンダリーからプライマリーに逆方向にレプリケートされます。どちらかのクラスターでのイメージのプロモートとデモートを可能にするには、両方のクラスターで rbd-mirror が実行されている必要があります。現在、双方向レプリケーションは 2 つのサイトの間でのみサポートされています。

双方向のミラーリングを機能させるには、いくつかの前提条件があります。

- ストレージクラスターが 2 台あり、それらのクラスター間でイメージをどちらの方向にでも複製できる。

-

両方のストレージクラスターで

rbd-mirrorデーモンが実行されている。cluster1 上のプライマリーイメージは、リモートクラスター上のrbd-mirrorデーモンによって同期され、リモートクラスター上のイメージはプライマリーに同期されます。

図6.2 双方向ミラーリング

6.2.3. コマンドラインインターフェイスを使用した一方向ミラーリングの設定

一方向レプリケーションを使用する場合は、複数のセカンダリーストレージクラスターにミラーリングできます。

このセクションの例では、プライマリーイメージがあるプライマリーストレージクラスターを site-a、イメージを複製するセカンダリーストレージクラスターを site-b として参照することで、2 つのストレージクラスターを区別しています。これらの例で使用されるプール名は data と呼ばれます。

前提条件

- 少なくとも実行中の Red Hat Ceph Storage クラスターが 2 台ある。

- 各ストレージクラスターの Ceph クライアントノードへの Root レベルのアクセス。

- 管理者レベル権限が割り当てられた CephX ユーザー。

手順

両方のサイトで

cephadmシェルにログインします。例

cephadm shell cephadm shell

[root@site-a ~]# cephadm shell [root@site-b ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-bで、セカンダリークラスターでミラーデーモンのデプロイメントをスケジュールします。構文

ceph orch apply rbd-mirror --placement=NODENAME

ceph orch apply rbd-mirror --placement=NODENAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@site-b /]# ceph orch apply rbd-mirror --placement=host04

[ceph: root@site-b /]# ceph orch apply rbd-mirror --placement=host04Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記nodenameは、セカンダリークラスターでミラーリングを設定するホストです。site-aのイメージのジャーナリング機能を有効にします。新規イメージ の場合は、

--image-featureオプションを使用します。構文

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME --image-feature FEATURE FEATURE

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME --image-feature FEATURE FEATURECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@site-a /]# rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journaling

[ceph: root@site-a /]# rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journalingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記exclusive-lockがすでに有効にされている場合は、ジャーナリングのみを引数として使用します。それ以外の場合は、以下のエラーが返されます。one or more requested features are already enabled (22) Invalid argument

one or more requested features are already enabled (22) Invalid argumentCopy to Clipboard Copied! Toggle word wrap Toggle overflow 既存のイメージ の場合は、

rbd feature enableコマンドを使用します。構文

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE, FEATURE

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE, FEATURECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@site-a /]# rbd feature enable data/image1 exclusive-lock, journaling

[ceph: root@site-a /]# rbd feature enable data/image1 exclusive-lock, journalingCopy to Clipboard Copied! Toggle word wrap Toggle overflow デフォルトですべての新規イメージのジャーナリングを有効にするには、

ceph config setコマンドを使用して設定パラメーターを設定します。例

[ceph: root@site-a /]# ceph config set global rbd_default_features 125 [ceph: root@site-a /]# ceph config show mon.host01 rbd_default_features

[ceph: root@site-a /]# ceph config set global rbd_default_features 125 [ceph: root@site-a /]# ceph config show mon.host01 rbd_default_featuresCopy to Clipboard Copied! Toggle word wrap Toggle overflow

両方のストレージクラスターで、ミラーリングモード (pool または image モード) を選択します。

プールモード の有効化:

構文

rbd mirror pool enable POOL_NAME MODE

rbd mirror pool enable POOL_NAME MODECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@site-a /]# rbd mirror pool enable data pool [ceph: root@site-b /]# rbd mirror pool enable data pool

[ceph: root@site-a /]# rbd mirror pool enable data pool [ceph: root@site-b /]# rbd mirror pool enable data poolCopy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

dataという名前のプール全体のミラーリングを有効にします。イメージモード の有効化:

構文

rbd mirror pool enable POOL_NAME MODE

rbd mirror pool enable POOL_NAME MODECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@site-a /]# rbd mirror pool enable data image [ceph: root@site-b /]# rbd mirror pool enable data image

[ceph: root@site-a /]# rbd mirror pool enable data image [ceph: root@site-b /]# rbd mirror pool enable data imageCopy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

dataという名前のプールでイメージモードのミラーリングを有効にします。注記プールの特定イメージのミラーリングを有効にするには、Red Hat Ceph Storage ブロックデバイスガイド の イメージミラーリングの有効化 セクションを参照してください。

両方のサイトでミラーリングが正常に有効になっていることを確認します。

構文

rbd mirror pool info POOL_NAME

rbd mirror pool info POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Ceph クライアントノードで、ストレージクラスターのピアをブートストラップします。

Ceph ユーザーアカウントを作成し、ストレージクラスターのピアをプールに登録します。

構文

rbd mirror pool peer bootstrap create --site-name PRIMARY_LOCAL_SITE_NAME POOL_NAME > PATH_TO_BOOTSTRAP_TOKEN

rbd mirror pool peer bootstrap create --site-name PRIMARY_LOCAL_SITE_NAME POOL_NAME > PATH_TO_BOOTSTRAP_TOKENCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@rbd-client-site-a /]# rbd mirror pool peer bootstrap create --site-name site-a data > /root/bootstrap_token_site-a

[ceph: root@rbd-client-site-a /]# rbd mirror pool peer bootstrap create --site-name site-a data > /root/bootstrap_token_site-aCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記以下の bootstrap コマンド例では、

client.rbd-mirror.site-aおよびclient.rbd-mirror-peerCeph ユーザーを作成します。-

ブートストラップトークンファイルを

site-bストレージクラスターにコピーします。 site-bストレージクラスターでブートストラップトークンをインポートします。構文

rbd mirror pool peer bootstrap import --site-name SECONDARY_LOCAL_SITE_NAME --direction rx-only POOL_NAME PATH_TO_BOOTSTRAP_TOKEN

rbd mirror pool peer bootstrap import --site-name SECONDARY_LOCAL_SITE_NAME --direction rx-only POOL_NAME PATH_TO_BOOTSTRAP_TOKENCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@rbd-client-site-b /]# rbd mirror pool peer bootstrap import --site-name site-b --direction rx-only data /root/bootstrap_token_site-a

[ceph: root@rbd-client-site-b /]# rbd mirror pool peer bootstrap import --site-name site-b --direction rx-only data /root/bootstrap_token_site-aCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記一方向 RBD ミラーリングでは、ピアのブートストラップ時に双方向のミラーリングがデフォルトであるため

--direction rx-only引数を使用する必要があります。

検証手順

ミラーリングのステータスを確認するには、プライマリーサイトおよびセカンダリーサイトの Ceph Monitor ノードから以下のコマンドを実行します。

構文

rbd mirror image status POOL_NAME/IMAGE_NAME

rbd mirror image status POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここでは

upはrbd-mirrorデーモンが実行中で、stoppedは、このイメージが別のストレージクラスターからのレプリケーション先ではないことを意味します。これは、イメージがこのストレージクラスターのプライマリーであるためです。例

[ceph: root@mon-site-b /]# rbd mirror image status data/image1 image1: global_id: c13d8065-b33d-4cb5-b35f-127a02768e7f

[ceph: root@mon-site-b /]# rbd mirror image status data/image1 image1: global_id: c13d8065-b33d-4cb5-b35f-127a02768e7fCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.4. コマンドラインインターフェイスを使用した双方向ミラーリングの設定

双方向レプリケーションを使用する場合にミラーリングできるのは、2 つのストレージクラスター間だけです。

このセクションの例には、プライマリーイメージでプライマリーストレージクラスターを site-a として、そのイメージをレプリケートするセカンダリーストレージクラスターを site-b として参照し、2 つのストレージクラスターを区別します。これらの例で使用されるプール名は data と呼ばれます。

前提条件