Data Grid 開発者ガイド

Data Grid のドキュメント

概要

第1章 Red Hat Data Grid

Data Grid は、高性能の分散型インメモリーデータストアです。

- スキーマレスデータ構造

- さまざまなオブジェクトをキーと値のペアとして格納する柔軟性があります。

- グリッドベースのデータストレージ

- クラスター間でデータを分散および複製するように設計されています。

- エラスティックスケーリング

- サービスを中断することなく、ノードの数を動的に調整して要件を満たします。

- データの相互運用性

- さまざまなエンドポイントからグリッド内のデータを保存、取得、およびクエリーします。

1.1. Data Grid のドキュメント

Data Grid のドキュメントは、Red Hat カスタマーポータルで入手できます。

1.2. Data Grid のダウンロード

Red Hat カスタマーポータルで Data Grid Software Downloads にアクセスします。

Data Grid ソフトウェアにアクセスしてダウンロードするには、Red Hat アカウントが必要です。

第2章 Data Grid Maven リポジトリーの設定

Data Grid Java ディストリビューションは Maven から入手できます。

顧客ポータルから Data Grid Maven リポジトリーをダウンロードするか、パブリック Red Hat Enterprise Maven リポジトリーから Data Grid 依存関係をプルできます。

2.1. Data Grid Maven リポジトリーのダウンロード

パブリック Red Hat Enterprise Maven リポジトリーを使用しない場合は、ローカルファイルシステム、Apache HTTP サーバー、または Maven リポジトリーマネージャーに Data Grid Maven リポジトリーをダウンロードし、インストールします。

手順

- Red Hat カスタマーポータルにログインします。

- Software Downloads for Data Grid に移動します。

- Red Hat Data Grid 8.0 Maven リポジトリーをダウンロードします。

- アーカイブされた Maven リポジトリーをローカルファイルシステムに展開します。

-

README.mdファイルを開き、適切なインストール手順に従います。

2.2. Red Hat GA Maven リポジトリーの追加

Maven 設定ファイル (通常は ~/.m2/settings.xml) を設定して、Red Hat GA リポジトリーを追加します。または、リポジトリーをプロジェクトの pom.xml ファイルに直接追加します。

以下の設定では、パブリックの Red Hat Enterprise Maven リポジトリーを使用します。Red Hat カスタマーポータルからダウンロードした Data Grid Maven リポジトリーを使用するには、url 要素の値を正しい場所に変更します。

2.3. Data Grid POM の設定

Maven は、プロジェクトオブジェクトモデル (POM) ファイルと呼ばれる設定ファイルを使用して、プロジェクトを定義し、ビルドを管理します。POM ファイルは XML 形式であり、モジュールとコンポーネントの依存関係、ビルドの順序、および結果となるプロジェクトのパッケージ化と出力のターゲットを記述します。

手順

-

プロジェクト

pom.xmlを開いて編集します。 -

正しい Data Grid バージョンで

version.infinispanプロパティーを定義します。 dependencyManagementセクションにinfinispan-bomを含めます。BOM(Bill of Materials) は、依存関係バージョンを制御します。これにより、バージョンの競合が回避され、プロジェクトに依存関係として追加する Data Grid アーティファクトごとにバージョンを設定する必要がなくなります。

-

pom.xmlを保存して閉じます。

以下の例は、Data Grid のバージョンと BOM を示しています。

次のステップ

必要に応じて、Data Grid アーティファクトを依存関係として pom.xml に追加します。

第3章 キャッシュマネージャー

CacheManager インターフェイスは Data Grid の主なエントリーポイントであり、以下を可能にします。

- キャッシュを設定および取得します。

- ノードの管理およびモニター

- クラスター全体でコードを実行する

- 詳細情報

Data Grid をアプリケーションに埋め込むか、リモートサーバーとして実行するかに応じて、EmbeddedCacheManager または RemoteCacheManager のいずれかを使用します。それらは一部のメソッドとプロパティーを共有しますが、それらにはセマンティックの違いがあることに注意してください。以下の章では、組み込み 実装の多くに重点を置いています。

CacheManager はヘビーウェイトオブジェクトであり、JVM ごとに複数の CacheManager が使用されないようにします(特定のセットアップに複数の設定が必要でない限り、いずれの方法でも最小および有限のインスタンス数になります)。

CacheManager を作成する最も簡単な方法は、以下のとおりです。

EmbeddedCacheManager manager = new DefaultCacheManager();

EmbeddedCacheManager manager = new DefaultCacheManager();キャッシュなしで最も基本的なローカルモード、クラスター化されていないキャッシュマネージャーを開始します。CacheManagers にはライフサイクルがあり、デフォルトのコンストラクターも Lifecycle.start() を呼び出します。コンストラクターの過負荷バージョンが利用できます。CacheManager は起動しませんが、CacheManager を使用して Cache インスタンスを作成する前に、CacheManager を起動する必要があることに注意してください。

構築後は、JNDI、ServletContext、または IoC コンテナーなどの他のメカニズムを使用して対話する必要のあるコンポーネントで CacheManagers を利用できるようにする必要があります。

CacheManager で終了したら、manager.stop(); のリソースを解放できるように停止する必要があります。

これにより、スコープ内のすべてのキャッシュが適切に停止され、スレッドプールがシャットダウンされます。CacheManager がクラスター化されている場合、クラスターも適切に残ります。

3.1. キャッシュの取得

CacheManager を設定した後、キャッシュを取得および制御できます。

以下のように、キャッシュを取得するために getCache(String) メソッドを呼び出します。

Cache<String, String> myCache = manager.getCache("myCache");

Cache<String, String> myCache = manager.getCache("myCache");

上記の操作は、myCache という名前のキャッシュがまだ存在しない場合は作成し、それを返します。

getCache() メソッドを使用すると、メソッドを呼び出すノードにのみキャッシュが作成されます。つまり、クラスター全体の各ノードで呼び出す必要のあるローカル操作を実行します。通常、複数のノードにまたがってデプロイされたアプリケーションは、初期化中にキャッシュを取得して、キャッシュが対称であり、各ノードに存在することを確認します。

createCache() メソッドを呼び出して、以下のようにクラスター全体でキャッシュを動的に作成します。

Cache<String, String> myCache = manager.administration().createCache("myCache", "myTemplate");

Cache<String, String> myCache = manager.administration().createCache("myCache", "myTemplate");上記の操作では、後でクラスターに参加するすべてのノードにキャッシュが自動的に作成されます。

createCache() メソッドを使用して作成するキャッシュは、デフォルトでは一時的です。クラスター全体がシャットダウンした場合、再起動時にキャッシュが自動的に再作成されることはありません。

PERMANENT フラグを使用して、以下のようにキャッシュが再起動後も存続できるようにします。

Cache<String, String> myCache = manager.administration().withFlags(AdminFlag.PERMANENT).createCache("myCache", "myTemplate");

Cache<String, String> myCache = manager.administration().withFlags(AdminFlag.PERMANENT).createCache("myCache", "myTemplate");PERMANENT フラグを有効にするには、グローバルの状態を有効にし、設定ストレージプロバイダーを設定する必要があります。

設定ストレージプロバイダーの詳細は、GlobalStateConfigurationBuilder#configurationStorage() を参照してください。

3.2. クラスターリング情報

EmbeddedCacheManager には、クラスターの動作に関する情報を提供するためのメソッドが多数あります。以下のメソッドは、クラスター環境で使用される場合 (Transport が設定されている場合) にのみ意味があります。

3.3. メンバー情報

クラスターを使用している場合、クラスターの所有者が誰であるかなど、クラスターのメンバーシップに関する情報を見つけられることが非常に重要となります。

getMembers() メソッドは、現在のクラスター内のすべてのノードを返します。

getCoordinator() メソッドは、どのメンバーがクラスターのコーディネーターであるかを指示します。ほとんどの場合、コーディネーターが誰であるかを気にする必要はありません。isCoordinator() メソッドを直接使用して、ローカルノードがコーディネーターであるかどうかを確認することもできます。

第4章 Data Grid キャッシュインターフェイス

Data Grid は、JDK の ConcurrentMap インターフェイスによって公開されるアトミックメカニズムを含む、エントリーを追加、取得、および削除するための簡単なメソッドを公開する Cache インターフェイスを提供します。使用されるキャッシュモードに基づいて、これらのメソッドを呼び出すと、リモートノードにエントリーを複製したり、リモートノードからエントリーを検索することやキャッシュストアからエントリーを検索することなど、数多くのことが発生します。

4.1. キャッシュ API

単純な使用の場合、Cache API の使用は JDK Map API の使用と違いがないはずです。したがって、マップに基づく単純なインメモリーキャッシュから Data Grid のキャッシュへの移行は簡単になります。

4.1.1. 特定のマップメソッドのパフォーマンスに関する懸念

size()、values()、keySet()、および entrySet() など、マップで公開される特定のメソッドは、Data Grid と使用すると特定のパフォーマンスに影響します。keySet の特定のメソッドである values および entrySet を使用できます。詳細については、Javadoc を参照してください。

これらの操作をグローバルに実行しようとすると、パフォーマンスに大きな影響を及ぼし、スケーラビリティーのボトルネックにもなります。そのため、これらの方法は情報またはデバッグの目的でのみ使用してください。

withFlags() メソッドで特定のフラグを使用すると、これらの問題の一部を軽減できます。詳細は、各メソッドのドキュメントを参照してください

4.1.2. Mortal および Immortal データ

単にエントリーを格納するだけでなく、Data Grid のキャッシュ API を使用すると、期限付き情報をデータに添付できます。たとえば、単に put(key, value) を使用すると、immortal エントリーが作成されます。このエントリーは削除されるまで (またはメモリー不足にならないようにメモリーからエビクトされるまで)、いつまでもキャッシュに存在します。ただし、put(key, value, lifespan, timeunit) を使用してキャッシュにデータを配置すると、mortal エントリーが作成されます。これは固定のライフスパンのあるエントリーで、そのライフスパンの後に期限切れになります。

Data Grid は、lifespanの他に、有効期限を決定する追加のメトリクスとしてmaxIdleもサポートします。lifespans または maxIdles の任意の組み合わせを使用できます。

4.1.3. putForExternalRead 操作

Data Grid の Cache クラスには、putForExternalRead と呼ばれる異なる 'put' 操作が含まれます。この操作は、他の場所で保持されるデータの一時キャッシュとして Data Grid が使用される場合に特に便利です。読み取りが非常に多い場合、キャッシュは単に最適化のために行われ、妨害するものではないため、キャッシュの競合によって実際のトランザクションが遅延してはなりません。

これを実現するため、キーがキャッシュ内に存在しない場合にのみ動作する put 呼び出しとしてputForExternalRead()が動作し、別のスレッドが同じキーを同時に格納しようとすると、通知なしに即座に失敗します。このシナリオでは、データのキャッシュはシステムを最適化する方法で、キャッシングの失敗が実行中のトランザクションに影響するのは望ましくないため、失敗の処理方法が異なります。成功したかどうかに関わらず、ロックを待たず、読み出し元に即座に返されるため、putForExternalRead()は高速な操作とみなされます。

この操作の使用方法を理解するために、基本的な例を見てみましょう。PersonId によって入力される Person インスタンスのキャッシュを想像してください。このデータは個別のデータストアから入力されます。以下のコードは、この例のコンテキスト内で putForExternalRead を使用する最も一般的なパターンを示しています。

putForExternalRead は、アプリケーションの実行元 (Person のアドレスを変更するトランザクションからなど) となる新しい Person インスタンスでキャッシュを更新するメカニズムとして使用しないでください。キャッシュされた値を更新する場合は、標準の put 操作を使用してください。使用しないと、破損したデータをキャッシュする可能性が高くなります。

4.2. AdvancedCache API

簡単なキャッシュインターフェイスの他に、Data Grid はエクステンション作成者向けに AdvancedCache インターフェイスを提供します。AdvancedCache は、特定の内部コンポーネントにアクセスし、フラグを適用して特定のキャッシュメソッドのデフォルト動作を変更する機能を提供します。次のコードスニペットは、AdvancedCache を取得する方法を示しています。

AdvancedCache advancedCache = cache.getAdvancedCache();

AdvancedCache advancedCache = cache.getAdvancedCache();4.2.1. フラグ

フラグは通常のキャッシュメソッドに適用され、特定のメソッドの動作を変更します。利用可能なフラグの一覧と、その効果については、Flag 列挙を参照してください。フラグは、AdvancedCache.withFlags() を使用して適用されます。このビルダーメソッドを使用して、キャッシュ呼び出しに任意の数のフラグを適用できます。次に例を示します。

advancedCache.withFlags(Flag.CACHE_MODE_LOCAL, Flag.SKIP_LOCKING)

.withFlags(Flag.FORCE_SYNCHRONOUS)

.put("hello", "world");

advancedCache.withFlags(Flag.CACHE_MODE_LOCAL, Flag.SKIP_LOCKING)

.withFlags(Flag.FORCE_SYNCHRONOUS)

.put("hello", "world");4.3. リスナーおよび通知

Data Grid はリスナー API を提供し、クライアントはイベントが発生したときに登録して通知を受け取ることができます。このアノテーション駆動型 API は、キャッシュレベルイベントとキャッシュマネージャーレベルイベントの 2 つの異なるレベルに適用されます。

イベントは、リスナーにディスパッチされる通知をトリガーします。リスナーは @Listener アノテーションが付けられ、Listenable インターフェイスで定義されたメソッドを使用して登録された単純な POJO です。

Cache と CacheManager はどちらも Listenable を実装しています。つまり、リスナーをキャッシュまたはキャッシュマネージャーのいずれかにアタッチして、キャッシュレベルまたはキャッシュマネージャーレベルのいずれかの通知を受信できます。

たとえば、次のクラスは、新しいエントリーがキャッシュに追加されるたびに、ブロックしない方法で、一部の情報を出力するようにリスナーを定義します。

より包括的な例は Javadocs for @Listener を参照してください。

4.3.1. キャッシュレベルの通知

キャッシュレベルのイベントはキャッシュごとに発生し、デフォルトでは、イベントが発生したノードでのみ発生します。分散キャッシュでは、これらのイベントは影響を受けるデータの所有者に対してのみ発生することに注意してください。キャッシュレベルのイベントの例としては、エントリーの追加、削除、変更などがあります。これらのイベントは、特定のキャッシュに登録されているリスナーへの通知をトリガーします。

すべてのキャッシュレベルの通知とそれぞれのメソッドレベルのアノテーションの包括的なリストについては、org.infinispan.notifications.cachelistener.annotation パッケージの Javadocs を参照してください。

Data Grid で使用可能なキャッシュレベルの通知のリストについては org.infinispan.notifications.cachelistener.annotation パッケージの Javadocs を参照してください。

4.3.1.1. クラスターリスナー

単一ノードでキャッシュイベントをリッスンすることが望ましい場合は、クラスターリスナーを使用する必要があります。

そのために必要なのは、リスナーがクラスター化されているというアノテーションを付けるよう設定することだけです。

@Listener (clustered = true)

public class MyClusterListener { .... }

@Listener (clustered = true)

public class MyClusterListener { .... }クラスター化されていないリスナーからのクラスターリスナーには、いくつかの制限があります。

-

クラスターリスナーは、

@CacheEntryModified、@CacheEntryCreated、@CacheEntryRemoved、および@CacheEntryExpiredイベントのみをリッスンできます。これは、他のタイプのイベントは、このリスナーに対してリッスンされないことを意味することに注意してください。 - ポストイベントのみがクラスターリスナーに送信され、プレイベントは無視されます。

4.3.1.2. イベントのフィルターリングおよび変換

リスナーがインストールされているノードで適用可能なすべてのイベントがリスナーに発生します。KeyFilter(キーのフィルターリングのみを許可) または CacheEventFilter(キー、古い値、古いメタデータ、新しい値、新しいメタデータ、コマンドの再実行の有無、イベントがイベント (isPre など) の前であるか、およびコマンドタイプのフィルターに使用) を使用して、どのイベントが発生したかを動的にフィルターできます。

この例で、イベントがキー Only Me のエントリーを変更したときにイベントのみを発生させる単純な KeyFilter を示しています。

これは、より効率的な方法で受信するイベントを制限したい場合に便利です。

また、イベントが発生する前に値を別の値に変換できるようにする CacheEventConverter もあります。これは、値の変換を行うコードをモジュール化するのに適しています。

上記のフィルターとコンバーターは、クラスターリスナーと組み合わせて使用すると特に効果的です。これは、イベントがリッスンされているノードではなく、イベントが発生したノードでフィルターリングと変換が行われるためです。これにより、クラスター全体でイベントを複製する必要がない (フィルター)、またはペイロードを減らす (コンバーター) という利点があります。

4.3.1.3. 初期状態のイベント

リスナーがインストールされると、完全にインストールされた後にのみイベントが通知されます。

リスナーの初回登録時にキャッシュコンテンツの現在の状態を取得することが望ましい場合があります。この場合、キャッシュ内の各要素の @CacheEntryCreated タイプのイベントが生成されます。この最初のフェーズで追加で生成されたイベントは、適切なイベントが発生するまでキューに置かれます。

現時点では、これはクラスター化されたリスナーに対してのみ機能します。ISPN-4608 では、クラスター化されていないリスナーへの追加を説明しています。

4.3.1.4. 重複イベント

トランザクションではないキャッシュで、重複したイベントを受け取ることが可能です。これは、put などの書き込み操作の実行中に、キーのプライマリー所有者がダウンした場合に可能になります。

Data Grid は、指定のキーの新規プライマリー所有者に put 操作を自動的に送信することで、put 操作を内部で修正しますが、最初に書き込みがバックアップに複製されたかどうかについては保証はありません。そのため、CacheEntryCreatedEvent、CacheEntryModifiedEvent、および CacheEntryRemovedEvent の書き込みイベントの 1 つ以上が、1 つの操作で送信される可能性があります。

複数のイベントが生成された場合、Data Grid は再試行コマンドによって生成されたイベントをマークし、変更の表示に注意を払いなくても、このイベントが発生したタイミングを把握できるようにします。

また、CacheEventFilter または CacheEventConverter を使用する場合、EventTypeには、再試行によりイベントが生成されたかどうかを確認するために、メソッド isRetry が含まれます。

4.3.2. キャッシュマネージャーレベルの通知

キャッシュマネージャーレベルのイベントは、キャッシュマネージャーで行われます。これらはグローバルでクラスター全体でもありますが、単一のキャッシュマネージャーによって作成されたすべてのキャッシュに影響するイベントが関係します。キャッシュマネージャーレベルのイベントの例として、クラスターに参加または退出するノード、または開始または停止するキャッシュがあります。

キャッシュマネージャーレベルのすべての通知とそれぞれのメソッドレベルのアノテーションの包括的なリストは、org.infinispan.notifications.cachemanagerlistener.annotation package を参照してください。

4.3.3. イベントの同期

デフォルトでは、すべての非同期通知は通知スレッドプールにディスパッチされます。同期通知は、リスナーメソッドが完了するか (スレッドがブロックする原因となる)、または CompletionStage が完了するまで、操作の続行を遅らせます。または、リスナーに非同期としてアノテーションを付けることもできます。この場合、操作は即座に継続され、通知は通知スレッドプールで非同期に完了します。これには、以下のようにリスナーにアノテーションを付けます。

非同期リスナー

@Listener (sync = false)

public class MyAsyncListener {

@CacheEntryCreated

void listen(CacheEntryCreatedEvent event) { }

}

@Listener (sync = false)

public class MyAsyncListener {

@CacheEntryCreated

void listen(CacheEntryCreatedEvent event) { }

}同期リスナーのブロック

@Listener

public class MySyncListener {

@CacheEntryCreated

void listen(CacheEntryCreatedEvent event) { }

}

@Listener

public class MySyncListener {

@CacheEntryCreated

void listen(CacheEntryCreatedEvent event) { }

}ノンブロッキングリスナー

@Listener

public class MyNonBlockingListener {

@CacheEntryCreated

CompletionStage<Void> listen(CacheEntryCreatedEvent event) { }

}

@Listener

public class MyNonBlockingListener {

@CacheEntryCreated

CompletionStage<Void> listen(CacheEntryCreatedEvent event) { }

}4.3.3.1. 非同期スレッドプール

このような非同期通知のディスパッチに使用されるスレッドプールを調整するには、設定ファイルの <listener-executor />XML 要素を使用します。

4.4. Asynchronous API

Cache.put()、Cache.remove() などの同期 API メソッドの他に、Data Grid には非同期のノンブロッキング API も含まれ、同じ結果をノンブロッキング方式で達成できます。

これらのメソッドの名前は、ブロックメソッドと同様の名前が付けられ、"Async"が追加されます。 E.g., Cache.putAsync() , Cache.removeAsync() , etc. これらの非同期のメソッドは、操作の実際の結果が含まれる CompletableFuture を返します。

たとえば、Cache<String, String> としてパラメーター化されたキャッシュでは、Cache.put(String key, String value) は String を返し、Cache.putAsync(String key, String value) は CompletableFuture<String> を返します。

4.4.1. このような API を使用する理由

ノンブロッキング API は、通信の失敗や例外を処理する機能を備えており、同期通信の保証をすべて提供するという点で強力なもので、呼び出しが完了するまでブロックする必要がありません。 これにより、システムで並列処理をより有効に活用できます。 以下に例を示します。

4.4.2. 実際に非同期で発生するプロセス

Data Grid には、通常の書き込み操作の重要なパスにあると見なされる 4 つの項目があります。これらの項目をコスト順に示します。

- ネットワークコール

- マーシャリング

- キャッシュストアへの書き込み (オプション)

- ロック

非同期メソッドを使用すると、ネットワーク呼び出しとマーシャリングがクリティカルパスから除外されます。 ただし、さまざまな技術的な理由により、キャッシュストアへの書き込みとロックの取得は、呼び出し元のスレッドで引き続き発生します。

第5章 データエンコーディングおよび MediaTypes

エンコーディングは、データを保存する前、およびストレージから読み戻すときに、Data Grid キャッシュによって実行されるデータ変換操作です。

5.1. 概要

エンコーディングを使用すると、API 呼び出し中に特定のデータ形式 (マップ、リスナー、ストリームなど) を処理できますが、効果的に保存される形式は異なります。

データ変換は、org.infinispan.commons.dataconversion.Encoder のインスタンスによって処理されます。

5.2. デフォルトのエンコーダー

Data Grid は、キャッシュ設定に応じてエンコーダーを自動的に選択します。以下の表は、複数の設定に使用される内部エンコーダーを示しています。

| Mode | 設定 | エンコーダー | 説明 |

|---|---|---|---|

| 組み込み/サーバー | デフォルト | IdentityEncoder | パススルーエンコーダ、変換なし |

| 組み込み | StorageType.OFF_HEAP | GlobalMarshallerEncoder | Data Grid の内部マーシャラーを使用して byte[] に変換します。キャッシュマネージャーで設定されたマーシャラーに委譲できます。 |

| 組み込み | StorageType.BINARY | BinaryEncoder | Data Grid の内部マーシャラーを使用して、プリミティブおよび String を除いて byte[] に変換します。 |

| Server | StorageType.OFF_HEAP | IdentityEncoder | リモートクライアントが受信したように byte[] を直接保存 |

5.3. プログラムでの上書き

AdvancedCache から .withEncoding() メソッドバリアントを呼び出すことで、キーと値の両方に使用されるエンコーディングをプログラムで上書きできます。

たとえば、OFF_HEAP として設定された以下のキャッシュについて考えてみましょう。

オーバーライドは、エントリー数のカウントや OFF_HEAP キャッシュの byte [] のサイズの計算など、キャッシュ内の操作にデコードが不要な場合に役立ちます。

5.4. カスタムエンコーダーの定義

カスタムエンコーダーは EncoderRegistry に登録できます。

キャッシュを起動する前に、クラスターの各ノードで登録が行われていることを確認してください。

gzip で圧縮/解凍するために使用されるカスタムエンコーダを考えてみましょう。

以下で登録できます。

GlobalComponentRegistry registry = cacheManager.getGlobalComponentRegistry(); EncoderRegistry encoderRegistry = registry.getComponent(EncoderRegistry.class); encoderRegistry.registerEncoder(new GzipEncoder());

GlobalComponentRegistry registry = cacheManager.getGlobalComponentRegistry();

EncoderRegistry encoderRegistry = registry.getComponent(EncoderRegistry.class);

encoderRegistry.registerEncoder(new GzipEncoder());次に、キャッシュからのデータの読み書きに使用します。

5.5. MediaType

任意で、キャッシュはキーと値の org.infinispan.commons.dataconversion.MediaType で設定できます。キャッシュのデータフォーマットを記述することで、Data Grid はキャッシュ操作中にデータを即座に変換できます。

MediaType 設定は、バイナリーデータを保存する場合により適しています。サーバーモードを使用する場合は、MediaType が設定され、REST または Hot Rod などのクライアントが異なる形式で読み取りおよび書き込みを行うのが一般的です。

MediaType 形式のデータ変換は、org.infinispan.commons.dataconversion.Transcoderのインスタンスによって処理されます。

5.5.1. 設定

宣言的 (Declarative)

プログラマティック

ConfigurationBuilder cfg = new ConfigurationBuilder();

cfg.encoding().key().mediaType("text/plain");

cfg.encoding().value().mediaType("application/json");

ConfigurationBuilder cfg = new ConfigurationBuilder();

cfg.encoding().key().mediaType("text/plain");

cfg.encoding().value().mediaType("application/json");5.5.2. プログラムで MediaType の上書き

異なる MediaType でキャッシュを切り離すことができるため、キャッシュ操作を異なるデータ形式を送受信できます。

以下に例を示します。

JSON 形式で値を返します。

{

"_type":"org.infinispan.sample.Person",

"name":"John",

"surname":"Doe"

}

{

"_type":"org.infinispan.sample.Person",

"name":"John",

"surname":"Doe"

}ほとんどの Transcoders は、サーバーモードの使用時にインストールされます。ライブラリーモードを使用する場合は、追加の依存関係 org.infinispan:infinispan-server-core をプロジェクトに追加します。

5.5.3. トランスコードおよびエンコーダー

通常、キャッシュ操作に関係するデータ変換はないか、1 つだけです。

- 組み込みモードまたはサーバーモードを使用したキャッシュでは、デフォルトでは変換されません。

- MediaType は設定されず、OFF_HEAP または BINARY を使用する組み込みキャッシュのエンコーダベースの変換。

- 複数の REST クライアントと Hot Rod クライアントが異なる形式でデータを送受信するサーバーモードで使用されるキャッシュの トランスコーダー ベースの変換。これらのキャッシュには、ストレージを記述する MediaType が設定されています。

ただし、高度なユースケースでは、エンコーダーとトランスコーダーの両方を同時に使用できます。

たとえば、マーシャリングされるオブジェクト (jboss marshaller を使用して) コンテンツを格納するキャッシュについて考えてみましょう。セキュリティー上の理由から、プレーンデータが外部ストアに格納されないように、透過的な暗号化レイヤーを追加する必要があります。クライアントは、複数の形式でデータを読み書きできる必要があります。

これは、エンコーディング層に関係なく、ストレージを記述する MediaType を使用してキャッシュを設定することで実現できます。

ConfigurationBuilder cfg = new ConfigurationBuilder();

cfg.encoding().key().mediaType("application/x-jboss-marshalling");

cfg.encoding().key().mediaType("application/x-jboss-marshalling");

ConfigurationBuilder cfg = new ConfigurationBuilder();

cfg.encoding().key().mediaType("application/x-jboss-marshalling");

cfg.encoding().key().mediaType("application/x-jboss-marshalling");透過的な暗号化は、たとえば次のように、保存/取得で暗号化/復号化する特別な エンコーダー でキャッシュをデコレートすることで追加できます。

キャッシュに書き込まれるすべてのデータが暗号化され保存されるようにするには、上記のエンコーダーでキャッシュをデコレートし、このデコレートされたキャッシュですべてのキャッシュ操作を実行する必要があります。

Cache<?,?> secureStorageCache = cache.getAdvancedCache().withEncoding(Scrambler.class).put(k,v);

Cache<?,?> secureStorageCache = cache.getAdvancedCache().withEncoding(Scrambler.class).put(k,v);キャッシュを目的の MediaType でデコレートすることにより、複数の形式でデータを読み取る機能を追加できます。

// Obtain a stream of values in XML format from the secure cache

secureStorageCache.getAdvancedCache().withMediaType("application/xml","application/xml").values().stream();

// Obtain a stream of values in XML format from the secure cache

secureStorageCache.getAdvancedCache().withMediaType("application/xml","application/xml").values().stream();内部的には、Data Grid は最初にエンコーダー fromStorage 操作を適用して、application/x-jboss-marshalling 形式のエントリーを取得し、次に適切なトランスコーダーを使用して application/xml に順次変換を適用します。

第6章 プロトコルの相互運用性

クライアントは、REST や Hot Rod などのエンドポイントを介して Data Grid とデータを交換します。

各エンドポイントは異なるプロトコルを使用するため、クライアントが適切な形式でデータの読み取りと書き込みを行うことができます。Data Grid は複数のクライアントと同時に相互運用できるため、クライアント形式とストレージ形式間でデータを変換する必要があります。

Data Grid エンドポイントの相互運用性を設定するには、キャッシュに保存されているデータの形式を設定する MediaType を定義する必要があります。

6.1. メディアタイプおよびエンドポイント相互運用性に関する考慮事項

特定のメディアタイプでデータを保存するように Data Grid を設定すると、クライアントの相互運用性に影響します。

REST クライアントはエンコードされたバイナリーデータの送受信をサポートしますが、JSON、XML、プレーンテキストなどのテキスト形式を処理する方が適切です。

Memcached テキストクライアントは、String ベースのキーと byte[] の値を処理できますが、サーバーとデータ型をネゴシエートすることはできません。これらのクライアントは、プロトコル定義が原因でデータ形式を処理する際に柔軟性が高くありません。

Java Hot Rod クライアントは、キャッシュに存在するエンティティーを表す Java オブジェクトを処理するのに適しています。Java Hot Rod クライアントはマーシャリング操作を使用して、これらのオブジェクトをバイトアレイにシリアライズおよびデシリアライズします。

同様に、C++、C#、Javascript クライアントなどの Java Hot Rod クライアントは、それぞれの言語でオブジェクトを処理するのに適しています。ただし、Java 以外の Hot Rod クライアントは、プラットフォームに依存しないデータ形式を使用して Java Hot Rod クライアントと相互運用できます。

6.2. REST、Hot Rod、および Memcached のテキストベースのストレージとの相互運用性

テキストベースのストレージ形式でキーと値を設定できます。

たとえば、text/plain; charset=UTF-8 またはその他の文字セットを指定して、プレーンテキストをメディアタイプとして設定します。オプションの文字セットを使用して、JSON (application/json)や XML (application/xml)などの他のテキストベースの形式のメディアタイプを指定することもできます。

以下の例では、text/plain; charset=UTF-8 メディアタイプでエントリーを保存するようにキャッシュを設定します。

テキストベースの形式でデータの交換を処理するには、org.infinispan.commons.marshall.StringMarshaller マーシャラーで Hot Rod クライアントを設定する必要があります。

以下のように、キャッシュへの書き込みおよび読み取り時に、REST クライアントは正しいヘッダーも送信する必要があります。

-

書き込み:

Content-Type: text/plain; charset=UTF-8 -

読み取り:

Accept: text/plain; charset=UTF-8

Memcached クライアントでは、テキストベースの形式を処理するための設定は必要ありません。

| この設定は、以下と互換性があります。 | |

|---|---|

| REST クライアント | はい |

| Java Hot Rod クライアント | はい |

| Memcached クライアント | はい |

| Java 以外の Hot Rod クライアント | いいえ |

| クエリーおよびインデックス | いいえ |

| カスタム Java オブジェクト | いいえ |

6.3. REST、Hot Rod、および Memcached とカスタム Java オブジェクトとの相互運用性

エントリーをマーシャリングされたカスタム Java オブジェクトとして保存する場合は、マーシャリングされたストレージの MediaType でキャッシュを設定する必要があります。

Java Hot Rod クライアントは、JBoss マーシャリングストレージ形式をデフォルトとして使用し、エントリーをカスタム Java オブジェクトとしてキャッシュに保存します。

以下の例では、application/x-jboss-marshalling メディアタイプでエントリーを保存するようにキャッシュを設定します。

Protostream マーシャラーを使用する場合は、MediaType を application/x-protostream として設定します。UTF8Marshaller の場合は、MediaType を text/plain として設定します。

Hot Rod クライアントのみがキャッシュと対話する場合は、MediaType を設定する必要はありません。

REST クライアントはテキスト形式の処理に最も適しているため、キーには java.lang.String などのプリミティブを使用する必要があります。それ以外の場合、REST クライアントは、サポートされるバイナリーエンコーディング を使用してキーを bytes[] として処理する必要があります。

REST クライアントは、XML または JSON 形式でキャッシュエントリーの値を読み取ることができます。ただし、クラスはサーバーで使用できる必要があります。

Memcached クライアントからデータを読み書きするには、キーに java.lang.String を使用する必要があります。値はマーシャリングされたオブジェクトとして保存され、返されます。

一部の Java Memcached クライアントは、オブジェクトをマーシャリングおよびアンマーシャリングするデータトランスフォーマーを許可します。また、言語に依存しない JSON などの異なる形式で応答をエンコードするように Memcached サーバーモジュールを設定することもできます。これにより、キャッシュのストレージの形式が Java 固有の場合でも、Java 以外のクライアントはデータと対話できます。

Java オブジェクトをキャッシュに保存するには、エンティティークラスを Data Grid にデプロイする必要があります。エンティティークラスのデプロイ を参照してください。

| この設定は、以下と互換性があります。 | |

|---|---|

| REST クライアント | はい |

| Java Hot Rod クライアント | はい |

| Memcached クライアント | はい |

| Java 以外の Hot Rod クライアント | いいえ |

| クエリーおよびインデックス | いいえ |

| カスタム Java オブジェクト | はい |

6.4. Protobuf を使用した Java および非 Java クライアントの相互運用性

Protobuf でエンコードされたエントリーとしてデータをキャッシュに保存すると、Java および非 Java クライアントが任意のエンドポイントからキャッシュにアクセスしてクエリーできるようにするプラットフォームに依存しない設定が提供されます。

キャッシュに対してインデックスが設定されると、Data Grid は application/x-protostream メディアタイプでキーと値を自動的に保存します。

キャッシュに対してインデックスが設定されていない場合は、以下のように application/x-protostream メディアタイプでエントリーを保存するように設定できます。

Data Grid は、application/x-protostream と application/json の間で変換します。これにより、REST クライアントは JSON 形式のデータの読み取りと書き込みが可能になります。ただし、REST クライアントは以下のように正しいヘッダーを送信する必要があります。

- ヘッダーの読み取り

Read: Accept: application/json

Read: Accept: application/json- ヘッダーの書き込み

Write: Content-Type: application/json

Write: Content-Type: application/json

application/x-protostream メディアタイプは Protobuf エンコーディングを使用します。これには、クライアントが使用するエンティティーおよびマーシャラーを記述する Protocol Buffers スキーマ定義を登録する必要があります。

| この設定は、以下と互換性があります。 | |

|---|---|

| REST クライアント | はい |

| Java Hot Rod クライアント | はい |

| Java 以外の Hot Rod クライアント | はい |

| クエリーおよびインデックス | はい |

| カスタム Java オブジェクト | はい |

6.5. カスタムコードの相互運用性

Data Grid でカスタムコードをデプロイできます。たとえば、スクリプト、タスク、リスナー、コンバーター、およびマージポリシーをデプロイできます。カスタムコードはキャッシュ内のデータに直接アクセスできるため、異なるエンドポイントを介してキャッシュ内のデータにアクセスするクライアントと相互運用する必要があります。

たとえば、キャッシュに保存されているカスタムオブジェクトを処理するリモートタスクを作成し、他のクライアントはデータをバイナリー形式で保存します。

カスタムコードとの相互運用性を処理するには、データをオンデマンドで変換するか、Plain Old Java Objects (POJO)としてデータを保存することができます。

6.5.1. Converting Data On Demand

application/x-protostream や application/x-jboss-marshalling などのバイナリー形式でデータを保存するようにキャッシュが設定されている場合は、Java オブジェクトをメディアタイプとして使用してキャッシュ操作を実行するようにデプロイされたコードを設定できます。MediaType プログラムの上書き を参照してください。

このアプローチにより、リモートクライアントはバイナリー形式を使用してキャッシュエントリーを保存することができます。これは最適です。ただし、バイナリー形式と Java オブジェクト間で変換できるように、エンティティークラスをサーバーで利用できるようにする必要があります。

さらに、キャッシュがバイナリー形式として Protobuf (application/x-protostream)を使用する場合は、Data Grid がカスタムコードからのデータをアンマーシャリングできるように protostream マーシャラーをデプロイする必要があります。

6.5.2. データを POJO として保存

アンマーシャリングされた Java オブジェクトをサーバーに保存することは推奨されません。これを実行するには、リモートクライアントがキャッシュから読み取られたときに Data Grid がデータをシリアライズし、リモートクライアントがキャッシュに書き込むときにデータをデシリアライズする必要があります。

以下の例では、application/x-java-object メディアタイプでエントリーを保存するようにキャッシュを設定します。

Hot Rod クライアントは、データが JBoss マーシャラーまたはデフォルトの Java シリアライゼーションメカニズムのいずれかである POJO として保存されている場合は、サポートされるマーシャラーを使用する必要があります。また、クラスをサーバーにデプロイする必要があります。

REST クライアントは、Data Grid が Java オブジェクト(現在 JSON または XML)との間で変換できるストレージ形式を使用する必要があります。

Java オブジェクトをキャッシュに保存するには、エンティティークラスを Data Grid にデプロイする必要があります。エンティティークラスのデプロイ を参照してください。

Memcached クライアントは、デフォルトで JBoss マーシャリングされたペイロードである、保存された POJO のシリアライズされたバージョンを送受信する必要があります。ただし、適切な Memcached コネクターでクライアントエンコーディングを設定する場合、Memcached クライアントが JSON などのプラットフォームに依存しない形式を使用するようにストレージ形式を変更します。

| この設定は、以下と互換性があります。 | |

|---|---|

| REST クライアント | はい |

| Java Hot Rod クライアント | はい |

| Java 以外の Hot Rod クライアント | いいえ |

| クエリーおよびインデックス | 有効。ただし、クエリーとインデックスは、エンティティーにアノテーションが付けられている場合にのみ POJO で機能します。 |

| カスタム Java オブジェクト | はい |

6.6. エンティティークラスのデプロイ

エントリーをカスタム Java オブジェクトまたは POJO としてキャッシュに保存する予定の場合は、エンティティークラスを Data Grid にデプロイする必要があります。クライアントは常にオブジェクトを bytes[] として交換します。エンティティークラスはこれらのカスタムオブジェクトを表し、Data Grid がそれらをシリアライズおよびデシリアライズできるようにします。

エンティティークラスをサーバーで利用可能にするには、以下の手順を実施します。

- エンティティーおよび依存関係が含まれる JAR ファイルを作成します。

- Data Grid が実行している場合は停止します。Data Grid は、起動時にエンティティークラスのみを読み込みます。

JAR を Data Grid サーバーのインストールの

server/libディレクトリーにコピーします。├── server │ ├── lib │ ├── deployment.my-entities.jar

├── server │ ├── lib │ ├── deployment.my-entities.jarCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第7章 Marshalling Java Objects

マーシャリングは、Java オブジェクトをバイナリー形式に変換して、ネットワーク経由で転送したり、ディスクに保存したりできるようにします。逆プロセスのアンマーシャリングは、データをバイナリー形式から Java オブジェクトに変換します。

Data Grid は、マーシャリングとアンマーシャリングを実行し、以下を行います。

- クラスターの他の Data Grid ノードにデータを送信します。

- データを永続キャッシュストアに保存します。

- データをバイナリー形式で格納し、遅延デシリアライズ機能を提供します。

Data Grid は、すべての内部タイプのマーシャリングを処理します。格納する Java オブジェクトに対してのみマーシャリングを設定する必要があります。

Data Grid は、Java オブジェクトをバイナリー形式にマーシャリングするデフォルトとして ProtoStream を使用します。Data Grid は、使用可能な他の Marshaller 実装も提供します。

7.1. Using the ProtoStream Marshaller

Data Grid は ProtoStream API と統合し、言語に依存しない下位互換性のある形式である Protocol Buffers (Protobuf)に Java オブジェクトをエンコードおよびデコードします。

手順

-

Data Grid が Java オブジェクトをマーシャリングできるように、ProtoStream

SerializationContextInitializerインターフェイスの実装を作成します。 実装を使用するように Data Grid を設定します。

プログラムで行う:

GlobalConfigurationBuilder builder = new GlobalConfigurationBuilder(); builder.serialization() .addContextInitializers(new LibraryInitializerImpl(), new SCIImpl());GlobalConfigurationBuilder builder = new GlobalConfigurationBuilder(); builder.serialization() .addContextInitializers(new LibraryInitializerImpl(), new SCIImpl());Copy to Clipboard Copied! Toggle word wrap Toggle overflow 宣言的に

<serialization> <context-initializer class="org.infinispan.example.LibraryInitializerImpl"/> <context-initializer class="org.infinispan.example.another.SCIImpl"/> </serialization><serialization> <context-initializer class="org.infinispan.example.LibraryInitializerImpl"/> <context-initializer class="org.infinispan.example.another.SCIImpl"/> </serialization>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2. JBoss Marshalling の使用

JBoss Marshalling はシリアル化ベースのマーシャリングライブラリーであり、以前の Data Grid バージョンではデフォルトのマーシャラーでした。

- Data Grid では、シリアル化ベースのマーシャリングを使用しないでください。代わりに、後方互換性を保証する高性能のバイナリーワイヤー形式である Protostream を使用する必要があります。

-

JBoss Marshalling および

AdvancedExternalizerインターフェイスは非推奨となり、今後のリリースで削除される予定です。しかし、Data Grid は、JBoss Marshalling を使用せずにデータを永続化したときにAdvancedExternalizer実装を無視します。

手順

-

infinispan-jboss-marshalling依存関係をクラスパスに追加します。 JBossUserMarshallerを使用するように Data Grid を設定します。プログラムで行う:

GlobalConfigurationBuilder builder = new GlobalConfigurationBuilder(); builder.serialization().marshaller(new JBossUserMarshaller());

GlobalConfigurationBuilder builder = new GlobalConfigurationBuilder(); builder.serialization().marshaller(new JBossUserMarshaller());Copy to Clipboard Copied! Toggle word wrap Toggle overflow 宣言的に行う:

<serialization marshaller="org.infinispan.jboss.marshalling.core.JBossUserMarshaller"/>

<serialization marshaller="org.infinispan.jboss.marshalling.core.JBossUserMarshaller"/>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3. Java シリアライゼーションの使用

Data Grid で Java シリアライゼーションを使用すると、Java オブジェクトが Java Serializable インターフェイスを実装する場合にのみ、オブジェクトをマーシャリングできます。

手順

-

JavaSerializationMarshallerをマーシャラーとして使用するように Data Grid を設定します。 Java クラスをデシリアライズホワイトリストに追加します。

プログラムで行う:

GlobalConfigurationBuilder builder = new GlobalConfigurationBuilder(); builder.serialization() .marshaller(new JavaSerializationMarshaller()) .whiteList() .addRegexps("org.infinispan.example.", "org.infinispan.concrete.SomeClass");GlobalConfigurationBuilder builder = new GlobalConfigurationBuilder(); builder.serialization() .marshaller(new JavaSerializationMarshaller()) .whiteList() .addRegexps("org.infinispan.example.", "org.infinispan.concrete.SomeClass");Copy to Clipboard Copied! Toggle word wrap Toggle overflow 宣言的に行う:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4. Kryo Marshaller の使用

Data Grid は、Kryo ライブラリーを使用するマーシャリング実装を提供します。

Data Grid サーバーの前提条件

Data Grid サーバーで Kryo マーシャリングを使用するには、以下のように Kryo マーシャリング実装のランタイムクラスファイルが含まれる JAR を追加します。

-

Data Grid Maven リポジトリーから

infinispan-marshaller-kryo-bundle.jarをコピーします。 -

JAR ファイルを Data Grid サーバーのインストールディレクトリーにある

server/libディレクトリーに追加します。

Data Grid ライブラリーモードの前提条件

Data Grid で Kryo マーシャリングをアプリケーションの埋め込みライブラリーとして使用するには、以下の手順を実行します。

infinispan-marshaller-kryo依存関係をpom.xmlに追加します。<dependency> <groupId>org.infinispan</groupId> <artifactId>infinispan-marshaller-kryo</artifactId> <version>${version.infinispan}</version> </dependency><dependency> <groupId>org.infinispan</groupId> <artifactId>infinispan-marshaller-kryo</artifactId> <version>${version.infinispan}</version> </dependency>Copy to Clipboard Copied! Toggle word wrap Toggle overflow org.infinispan.marshaller.kryo.KryoMarshallerクラスをマーシャラーとして指定します。GlobalConfigurationBuilder builder = new GlobalConfigurationBuilder(); builder.serialization() .marshaller(new org.infinispan.marshaller.kryo.KryoMarshaller());GlobalConfigurationBuilder builder = new GlobalConfigurationBuilder(); builder.serialization() .marshaller(new org.infinispan.marshaller.kryo.KryoMarshaller());Copy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

-

SerializerRegistryService.javaインターフェイスのサービスプロバイダーを実装します。 register(Kryo)メソッドにすべてのシリアライザー登録を配置します。シリアライザーは、Kryo API を使用して提供されたKryoオブジェクトに登録されます。以下に例を示します。kryo.register(ExampleObject.class, new ExampleObjectSerializer())

kryo.register(ExampleObject.class, new ExampleObjectSerializer())Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の範囲内で、デプロイメント JAR ファイルにクラスを実装するためのフルパスを指定します。

META-INF/services/org/infinispan/marshaller/kryo/SerializerRegistryService

META-INF/services/org/infinispan/marshaller/kryo/SerializerRegistryServiceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

参照資料

7.5. Protostuff Marshaller の使用

Data Grid は、Protostuff ライブラリーを使用するマーシャリング実装を提供します。

Data Grid サーバーの前提条件

Data Grid サーバーで Protostuff マーシャリングを使用するには、以下のように Protostuff マーシャリング実装のランタイムクラスファイルが含まれる JAR を追加します。

-

Data Grid Maven リポジトリーから

infinispan-marshaller-protostuff-bundle.jarをコピーします。 -

JAR ファイルを Data Grid サーバーのインストールディレクトリーにある

server/libディレクトリーに追加します。

Data Grid ライブラリーモードの前提条件

Data Grid で Protostuff マーシャリングをアプリケーションの埋め込みライブラリーとして使用するには、以下の手順を実行します。

infinispan-marshaller-protostuff依存関係をpom.xmlに追加します。<dependency> <groupId>org.infinispan</groupId> <artifactId>infinispan-marshaller-protostuff</artifactId> <version>${version.infinispan}</version> </dependency><dependency> <groupId>org.infinispan</groupId> <artifactId>infinispan-marshaller-protostuff</artifactId> <version>${version.infinispan}</version> </dependency>Copy to Clipboard Copied! Toggle word wrap Toggle overflow org.infinispan.marshaller.protostuff.ProtostuffMarshallerクラスをマーシャラーとして指定します。GlobalConfigurationBuilder builder = new GlobalConfigurationBuilder(); builder.serialization() .marshaller(new org.infinispan.marshaller.protostuff.ProtostuffMarshaller());GlobalConfigurationBuilder builder = new GlobalConfigurationBuilder(); builder.serialization() .marshaller(new org.infinispan.marshaller.protostuff.ProtostuffMarshaller());Copy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

オブジェクトマーシャリングのカスタム Protostuff スキーマを登録するには、以下のいずれかを行います。

register()メソッドを呼び出します。RuntimeSchema.register(ExampleObject.class, new ExampleObjectSchema());

RuntimeSchema.register(ExampleObject.class, new ExampleObjectSchema());Copy to Clipboard Copied! Toggle word wrap Toggle overflow register()メソッドにすべてのスキーマ登録を配置するSerializerRegistryService.javaインターフェイスのサービスプロバイダーを実装します。その後、以下の範囲内で、デプロイメント JAR ファイルにクラスを実装するためのフルパスを指定します。

META-INF/services/org/infinispan/marshaller/protostuff/SchemaRegistryService

META-INF/services/org/infinispan/marshaller/protostuff/SchemaRegistryServiceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

参照資料

7.6. カスタムマーシャラーの使用

Data Grid は、カスタムマーシャラーの Marshaller インターフェイスを提供します。

プログラムによる手順

GlobalConfigurationBuilder builder = new GlobalConfigurationBuilder();

builder.serialization()

.marshaller(new org.infinispan.example.marshall.CustomMarshaller())

.whiteList().addRegexp("org.infinispan.example.*");

GlobalConfigurationBuilder builder = new GlobalConfigurationBuilder();

builder.serialization()

.marshaller(new org.infinispan.example.marshall.CustomMarshaller())

.whiteList().addRegexp("org.infinispan.example.*");宣言型手順

カスタムマーシャラーの実装は、起動時に呼び出される initialize() メソッドを使用して設定済みの許可リストにアクセスできます。

7.7. Adding Java Classes to Deserialization White Lists

Data Grid では、セキュリティー上の理由から、任意の Java クラスのデシリアルは許可されません。これは、JSON、XML、およびマーシャリングされた byte[] コンテンツが該当します。

システムプロパティーを使用するか、または Data Grid 設定で Java クラスを指定して、デシリアライズホワイトリストに Java クラスを追加する必要があります。

システムプロパティー

// Specify a comma-separated list of fully qualified class names -Dinfinispan.deserialization.whitelist.classes=java.time.Instant,com.myclass.Entity // Specify a regular expression to match classes -Dinfinispan.deserialization.whitelist.regexps=.*

// Specify a comma-separated list of fully qualified class names

-Dinfinispan.deserialization.whitelist.classes=java.time.Instant,com.myclass.Entity

// Specify a regular expression to match classes

-Dinfinispan.deserialization.whitelist.regexps=.*宣言的 (Declarative)

デシリアライズホワイトリストに追加する Java クラスは、Data Grid CacheContainer に適用され、CacheContainer が制御するすべてのキャッシュによってデシリアライズできます。

7.8. Data Grid サーバーでシリアル化されたオブジェクトの保存

application/x-java-object MediaType をデータの形式として使用するように Data Grid を設定できます。つまり、Data Grid はデータをバイナリーコンテンツではなく Plain Old Java Objects (POJO)として保存します。

POJO を保存する場合は、すべてのカスタムオブジェクトのクラスファイルを Data Grid サーバークラスパスに配置する必要があります。

手順

-

server/libディレクトリーにマーシャラー実装用のカスタムクラスやサービスプロバイダーを含む JAR ファイルを追加します。

├── server │ ├── lib │ │ ├── UserObjects.jar │ └── README.txt

├── server

│ ├── lib

│ │ ├── UserObjects.jar

│ └── README.txt7.9. バイナリー形式でのデータの保存

Data Grid は、データをバイナリー形式でシリアライズされた形式で保存し、必要に応じて Java オブジェクトをシリアライズまたはデシリアライズできます。この動作は Lazy deserialization とも呼ばれます。

プログラムによる手順

ConfigurationBuilder builder = ... builder.memory().storageType(StorageType.BINARY);

ConfigurationBuilder builder = ...

builder.memory().storageType(StorageType.BINARY);宣言型手順

<memory> <binary /> </memory>

<memory>

<binary />

</memory>等価性に関する考慮事項

データをバイナリー形式で保存する場合、Data Grid はキーと値に WrappedBytes インターフェイスを使用します。このラッパークラスは、オンデマンドでシリアライズおよびデシリアライズを透過的に処理し、内部的には、ラップされているオブジェクト自体への参照、またはオブジェクトのシリアライズされたバイトアレイ表現を持つ場合があります。これは等価性の動作に影響します。これは、キーに equals() メソッドを実装する場合に注意することが重要です。

ラッパークラスの equals() メソッドは、比較対象の両方のインスタンスが比較時にシリアライズされた形式かデシリアライズされた形式かによって、バイナリー表現 (バイト配列) を比較するか、ラップされたオブジェクトインスタンスの equals() メソッドに委任します。比較される 2 つのインスタンスの形式が異なる場合、1 つのインスタンスはシリアライズまたはデシリアライズされます。

第8章 Marshalling Custom Java Objects with ProtoStream

Data Grid は ProtoStream API を使用して、言語に依存しない下位互換性のある形式で、Java オブジェクトをプロトコルバッファー (Protobuf) にエンコードおよびデコードします。

8.1. Protobuf スキーマ

プロトコルバッファー、Protobuf は Java オブジェクトの構造化表現を提供します。

Protobuf メッセージタイプの .proto スキーマファイルを以下の例のように定義します。

前述の .library.proto ファイルは、book_sample パッケージに含まれる Book という名前のエンティティー (Protobuf メッセージタイプ) を定義します。Book は、プリミティブ型のいくつかのフィールドと、Author メッセージタイプである authors という名前のアレイ (Protobuf 反復可能フィールド) を宣言します。

Protobuf メッセージ

- メッセージをネストできますが、結果的に構造は厳密にツリーであり、グラフではありません。

- 型の継承はできません。

- コレクションはサポート対象外ですが、フィールドを繰り返してアレイをエミュレートできます。

8.2. ProtoStream シリアライゼーションコンテキスト

ProtoStream SerializationContext には、.proto スキーマファイルからロードされたカスタム Java オブジェクトの Protobuf タイプ定義と、オブジェクトに付随するマーシャラーが含まれています。

SerializationContextInitializer インターフェイスは Java オブジェクトとマーシャラーを登録し、ProtoStream ライブラリーがカスタムオブジェクトを Protobuf 形式にエンコードできるようにします。これにより、Data Grid はデータを送信および保存できます。

8.3. ProtoStream タイプ

ProtoStream は、追加の設定なしで、以下のタイプやプリミティブタイプの場合に同等のタイプを処理できます。

-

String -

整数 -

Long -

double -

Float -

ブール値 -

byte[] -

Byte -

Short -

Character -

java.util.Date -

java.time.Instant

他の Java オブジェクトをマーシャリングするには、SerializationContext で .proto スキーマとマーシャラーを登録する SerializationContextInitializer 実装を生成または手動で作成する必要があります。

8.4. シリアル化コンテキストイニシャライザーの生成

Data Grid は、アノテーション付きの Java クラスから .proto スキーマと SerializationContextInitializer 実装を生成できる protostream-processor アーティファクトを提供します。

手順

protostream-processor依存関係をpom.xmlに追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow マーシャリングする Java オブジェクトに

@ProtoFieldと@ProtoFactoryアノテーションを付けます。Book.java

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Author.java

Copy to Clipboard Copied! Toggle word wrap Toggle overflow SerializationContextInitializerを拡張し、@AutoProtoSchemaBuilderアノテーションが付けられたインターフェイスを定義します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

コンパイル時に、protostream-processor は、ProtoStream SerializationContext の初期化に使用できるインターフェイスの具体的な実装を生成します。デフォルトでは、実装名は Impl 接尾辞が付いたアノテーション付きクラス名です。

例

以下は、生成されたスキーマファイルと実装の例です。

target/classes/proto/library.proto

LibraryInitializerImpl.java

8.5. シリアライゼーションコンテキストイニシャライザーの手動実装

場合によっては、.proto スキーマファイルを手動で定義し、ProtoStream マーシャラーを実装する必要がある場合があります。たとえば、Java オブジェクトクラスを変更してアノテーションを追加できない場合などです。

手順

Protobuf メッセージで

.protoスキーマを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow org.infinispan.protostream.MessageMarshallerインターフェイスを使用して、クラスのマーシャラーを実装します。BookMarshaller.java

Copy to Clipboard Copied! Toggle word wrap Toggle overflow AuthorMarshaller.java

Copy to Clipboard Copied! Toggle word wrap Toggle overflow .protoスキーマと ProtoStream マーシャラー実装をSerializationContextに登録するSerializationContextInitializer実装を作成します。ManualSerializationContextInitializer.java

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第9章 クラスター化されたロック

クラスター化されたロック は、Data Grid クラスターのすべてのノードに分散され、共有されるロックで、現在、特定のクラスターのノード間で同期されるコードを実行する方法を提供します。

9.1. インストール

クラスター化されたロックの使用を開始するには、Maven pom.xml ファイルに依存関係を追加する必要があります。

pom.xml

<dependency> <groupId>org.infinispan</groupId> <artifactId>infinispan-clustered-lock</artifactId> </dependency>

<dependency>

<groupId>org.infinispan</groupId>

<artifactId>infinispan-clustered-lock</artifactId>

</dependency>9.2. ClusteredLock 設定

現在、ClusteredLock の 1 つのタイプがサポートされています。reentrant、NODE 所有権ロックです。

9.2.1. 所有権

-

NODEは、ClusteredLockが定義されると、Data Grid クラスターのすべてのノードでこのロックを使用できます。所有権が NODE タイプである場合、ロックの所有者は、特定の時点でロックを取得する Data Grid ノードになります。つまり、ClusteredCacheManagerを使用してClusteredLockインスタンスを取得するたびに、このインスタンスは各 Data Grid ノードの同じインスタンスになります。このロックは、Data Grid ノード間のコードの同期に使用できます。このロックの利点は、ノード内のすべてのスレッドが特定のタイミングでロックを解放できることです。 -

INSTANCE- まだサポートされていません

ClusteredLock が定義されると、Data Grid クラスターのすべてのノードでこのロックを使用できます。所有権が INSTANCE タイプである場合、ロックの所有者は、ClusteredLockManager.get ("lockName") が呼び出される際に取得した実際のインスタンスになります。

これは、ClusteredCacheManager を使用して ClusteredLock インスタンスを取得するたびに、このインスタンスは新しいインスタンスになります。このロックを使用して、Data Grid ノード間でコードと各 Data Grid ノード間でコードを同期します。このロックの利点は、ロックを呼び出したインスタンスのみがロックを解放できることです。

9.2.2. 再入可能性

ClusteredLock がリエントラントに構成されている場合、ロックの所有者は、ロックを保持している間、何度でも連続してロックを再取得することができます。

現在、非リエントラントロックのみサポートされています。つまり、2 つの連続した lock 呼び出しが同じ所有者に対して送信されると、最初の呼び出しは利用可能な場合はロックを取得し、2 番目の呼び出しはブロックされます。

9.3. ClusteredLockManager インターフェイス

ClusteredLockManager インターフェースは、実験的とマークされて おり、ロックを定義、取得、削除するためのエントリポイントです。EmbeddedCacheManager の作成を自動的にリッスンし、EmbeddedCacheManager ごとのインスタンスの登録を続行します。ロック状態を保存するために必要な内部キャッシュを起動します。

ClusteredLockManager の取得は、以下の例のように EmbeddedClusteredLockManagerFactory.from(EmbeddedCacheManager) を呼び出すのと同じくらい簡単です。

// create or obtain your EmbeddedCacheManager EmbeddedCacheManager manager = ...; // retrieve the ClusteredLockManager ClusteredLockManager clusteredLockManager = EmbeddedClusteredLockManagerFactory.from(manager);

// create or obtain your EmbeddedCacheManager

EmbeddedCacheManager manager = ...;

// retrieve the ClusteredLockManager

ClusteredLockManager clusteredLockManager = EmbeddedClusteredLockManagerFactory.from(manager);-

defineLock: 指定された名前とデフォルトのClusteredLockConfigurationでロックを定義します。既存の設定を上書きしません。 -

defineLock (String name, ClusteredLockConfiguration configuration): 指定された名前とClusteredLockConfigurationのロックを定義します。既存の設定を上書きしません。 -

ClusteredLock get (String name): 名前を指定してClusteredLockを取得します。defineLockの呼び出しは、クラスター内で少なくとも 1 回実行する必要があります。getメソッド呼び出しの影響を理解するには、所有権 レベルセクションを参照してください。

現在、サポートされる唯一の所有権レベルは NODE のみです。

-

ClusteredLockConfiguration getConfiguration(String name):

ClusteredLock の設定を返します(存在する場合)。

-

boolean isDefined (String name): ロックがすでに定義されているかどうかを確認します。 -

CompletableFuture<Boolean> remove(String name): そのような場合はClusteredLockを削除します。 -

CompletableFuture<Boolean> forceRelease(String name): Releases - または unlocks - 存在する場合は、特定の時間に保持するユーザーに関係なく、ClusteredLock。このメソッドを呼び出すと、並行処理の問題が発生する可能性があるため、例外的な状況 で使用する必要があります。

9.4. ClusteredLock インターフェイス

実験的としてマーク されている ClusteredLock インターフェイスは、クラスター化されたロックを実装するインターフェイスです。

-

lock: ロックを取得します。ロックが利用できない場合は、ロックが取得されるまでブロックされます。現在、ロックリクエストが失敗する最大時間が指定されていないため、これによりスレッドが枯渇する可能性があります。 -

tryLockは、呼び出し時に解放されている場合にのみロックを取得し、その場合はtrueを返します。このメソッドは、ロックの取得をブロック(または待機)しません。 tryLock (long time, TimeUnit unit)ロックが利用可能な場合、このメソッドはtrueで即座に返します。ロックが利用できない場合、呼び出しは以下になるまで待機します。- ロックが取得される

- 指定された待機時間の経過時間

時間がゼロ以下の場合、メソッドはまったく待機しません。

-

unlock

ロックを解放します。ロックの所有者のみがロックを解放できます。

-

isLockedがロックされている場合はtrue、ロックがリリースされるとfalseを返します。 -

isLockedByMeロックが呼び出し元によって所有されている場合はtrueを、ロックが他の誰かによって所有されているか、解放されている場合はfalseを返します。

9.4.1. 使用例

9.4.2. ClusteredLockManager の設定

次の属性を使用して、宣言的またはプログラム的に、ロックに異なるストラテジーを使用するように ClusteredLockManager を設定できます。

num-owners-

クラスター化されたロックの状態を格納する各クラスターのノードの総数を定義します。デフォルト値は

-1で、値をすべてのノードに複製します。 reliabilityクラスターがパーティションに分割したり、複数のノードがクラスターから離れる場合にクラスター化されたロックがどのように動作するかを制御します。以下の値を設定できます。

-

AVAILABLE: 任意のパーティションのノードが、ロックで同時に操作することができます。 -

CONSISTENT: 大多数のパーティションに属するノードのみが、ロック上で動作できます。これはデフォルト値です。

-

以下は、ClusteredLockManager の宣言型設定の例です。

第10章 クラスター化カウンター

クラスター化されたカウンター は、Data Grid クラスターのすべてのノードで分散され、共有されるカウンターです。カウンターは異なる整合性レベル (strong および weak) を持つことができます。

strong/weak と一貫性のあるカウンターには個別のインターフェイスがありますが、どちらもその値の更新をサポートし、現在の値を返し、その値が更新されたときにイベントを提供します。このドキュメントでは、ユースケースに最適なものを選択する上で役立つ詳細を以下に示します。

10.1. インストールおよび設定

カウンターの使用を開始するには、Maven の pom.xml ファイルに依存関係を追加する必要があります。

pom.xml

<dependency> <groupId>org.infinispan</groupId> <artifactId>infinispan-clustered-counter</artifactId> </dependency>

<dependency>

<groupId>org.infinispan</groupId>

<artifactId>infinispan-clustered-counter</artifactId>

</dependency>

このカウンターは、本書で後述する CounterManager インターフェイスを介して、Data Grid 設定ファイルまたはオンデマンドを設定できます。EmbeddedCacheManager の起動時に、起動時に Data Grid 設定ファイルに設定されたカウンターが作成します。これらのカウンターは Eagerly で開始され、すべてのクラスターのノードで利用できます。

configuration.xml

または、プログラムを使用して GlobalConfigurationBuilder で以下を行います。

一方、このカウンターは、EmbeddedCacheManager を初期化した後にいつでも設定することができます。

CounterConfiguration は変更できず、再利用できます。

カウンターが正常に設定されていると、defineCounter() メソッドは true を返します。そうでない場合は、true を返します。ただし、設定が無効な場合は、メソッドによって CounterConfigurationException が発生します。カウンターがすでに定義されているかを調べるには、isDefined() メソッドを使用します。

CounterManager manager = ...

if (!manager.isDefined("someCounter")) {

manager.define("someCounter", ...);

}

CounterManager manager = ...

if (!manager.isDefined("someCounter")) {

manager.define("someCounter", ...);

}クラスターごとの属性:

-

num-owners: クラスター全体で保持するカウンターのコピー数を設定します。数値が小さいほど更新操作は高速になりますが、サポートされるサーバークラッシュの数は少なくなります。正の値である必要があり、デフォルト値は2です。 reliability: ネットワークパーティションでカウンターの更新動作を設定します。デフォルト値はAVAILABLEで、有効な値は次のとおりです。-

AVAILABLE: すべてのパーティションはカウンター値の読み取りと更新が可能です。 -

CONSISTENT: プライマリーパーティション (ノードの大多数) のみがカウンター値の読み取りと更新が可能です。残りのパーティションは、その値の読み取りのみ可能です。

-

カウンターごとの属性:

-

initial-value[common]: カウンターの初期値を設定します。デフォルトは0(ゼロ) です。 storage[common]: クラスターのシャットダウンおよび再起動時のカウンターの動作を設定します。デフォルト値はVOLATILEで、有効な値は次のとおりです。-

VOLATILE: カウンターの値はメモリーでのみ利用できます。この値は、クラスターがシャットダウンすると失われます。 -

PERSISTENT: カウンターの値はプライベートおよびローカル永続ストアに保存されます。この値は、クラスターがシャットダウンされたときに保持され、再起動後に復元されます。

-

オンデマンドおよび VOLATILE カウンターは、クラスターのシャットダウン後にその値と設定を失います。再起動後に再度定義する必要があります。

-

lower-bound[strong]: 強力な一貫性のあるカウンターの下限を設定します。デフォルト値はLong.MIN_VALUEです。 -

upper-bound[strong]: 強力な一貫性のあるカウンターの上限を設定します。デフォルト値はLong.MAX_VALUEです。

lower-bound も upper-bound も設定されていない場合は、強力なカウンターは無制限として設定されます。

initial-value は、lower-bound 以上 upper-bound 以下である必要があります。

-

concurrency-level[weak]: 同時更新の数を設定します。正の値である必要があり、デフォルト値は16です。

10.1.1. カウンター名の一覧表示

定義されたすべてのカウンターを一覧表示するには、CounterManager.getCounterNames() メソッドは、クラスター全体で作成されたすべてのカウンター名のコレクションを返します。

10.2. CounterManager インターフェイス

CounterManager インターフェイスは、カウンターを定義、取得、および削除するエントリーポイントです。EmbeddedCacheManager の作成を自動的にリッスンし、EmbeddedCacheManager ごとのインスタンスの登録を続行します。カウンター状態を保存し、デフォルトのカウンターの設定に必要なキャッシュを開始します。

CounterManager の取得は、以下の例のように EmbeddedCounterManagerFactory.asCounterManager(EmbeddedCacheManager) を呼び出すだけです。

// create or obtain your EmbeddedCacheManager EmbeddedCacheManager manager = ...; // retrieve the CounterManager CounterManager counterManager = EmbeddedCounterManagerFactory.asCounterManager(manager);

// create or obtain your EmbeddedCacheManager

EmbeddedCacheManager manager = ...;

// retrieve the CounterManager

CounterManager counterManager = EmbeddedCounterManagerFactory.asCounterManager(manager);

Hot Rod クライアントの場合、CounterManager は RemoteCacheManager に登録されており、以下のように取得できます。

// create or obtain your RemoteCacheManager RemoteCacheManager manager = ...; // retrieve the CounterManager CounterManager counterManager = RemoteCounterManagerFactory.asCounterManager(manager);

// create or obtain your RemoteCacheManager

RemoteCacheManager manager = ...;

// retrieve the CounterManager

CounterManager counterManager = RemoteCounterManagerFactory.asCounterManager(manager);10.2.1. CounterManager を介したカウンターの削除

注意して使用してください。

Strong/WeakCounter と CounterManager でカウンターを削除するのに違いがあります。CounterManager.remove(String) は、クラスターからカウンター値を削除し、ローカルカウンターインスタンスのカウンターに登録されているすべてのリスナーを削除します。さらに、カウンターインスタンスは再利用可能ではなくなり、無効な結果が返される可能性があります。

一方で、Strong/WeakCounter を削除するとカウンター値のみが削除されます。インスタンスは引き続き再利用でき、リスナーは引き続き動作します。

削除後にアクセスされると、カウンターは再作成されます。

10.3. カウンター

カウンターは、strong (StrongCounter) または weak(WeakCounter) になり、いずれも名前で識別されます。各インターフェイスには特定のインターフェイスがありますが、ロジック (つまり各操作により CompletableFuture が返される) を共有しているため、更新イベントが返され、初期値にリセットできます。

非同期 API を使用しない場合は、sync() メソッドを介して同期カウンターを返すことができます。API は同じですが、CompletableFuture の戻り値はありません。

以下のメソッドは、両方のインターフェイスに共通しています。

-

getName()はカウンター名 (identifier) を返します。 -

getValue()は現在のカウンターの値を返します。 -

reset()により、カウンターの値を初期値にリセットできます。 -

reset()はリスナーを登録し、更新イベントを受信します。詳細については、通知およびイベント セクションをご覧ください。 -

getConfiguration()はカウンターによって使用される設定を返します。 -

remove()はクラスターからカウンター値を削除します。インスタンスは引き続き使用でき、リスナーが保持されます。 -

sync()は同期カウンターを作成します。

削除後にアクセスされると、カウンターは再作成されます。

10.3.1. StrongCounter インターフェイス: 一貫性または境界が明確になります。

strong カウンターは、Data Grid キャッシュに保存されている単一のキーを使用して、必要な一貫性を提供します。すべての更新は、その値を更新するためにキーロックの下で実行されます。一方、読み取りはロックを取得し、現在の値を読み取ります。さらに、このスキームではカウンター値をバインドでき、比較および設定/スワップなどのアトミック操作を提供できます。

StrongCounter は、getStrongCounter() メソッドを使用して CounterManager から取得することができます。たとえば、以下のようになります。

CounterManager counterManager = ...

StrongCounter aCounter = counterManager.getStrongCounter("my-counter");

CounterManager counterManager = ...

StrongCounter aCounter = counterManager.getStrongCounter("my-counter");

すべての操作は単一のキーに到達するため、StrongCounter は競合レートが高くなります。

StrongCounter インターフェイスでは、以下のメソッドを追加します。

-

incrementAndGet()はカウンターを 1 つずつ増分し、新しい値を返します。 -

decrementAndGet()は、1 つずつカウンターをデクリメントし、新しい値を返します。 -

addAndGet()は、delta をカウンターの値に追加し、新しい値を返します。 -

compareAndSet()およびcompareAndSwap()は、現在の値が想定される場合にカウンターの値を設定します。

CompletableFuture が完了すると、操作は完了とみなされます。

compare-and-set と compare-and-swap の相違点は、操作に成功した場合に、compare-and-set は true を返しますが、compare-and-swap は前の値をか返すことです。戻り値が期待値と同じ場合は、compare-and-swap が正常になります。

10.3.1.1. バインドされた StrongCounter

バインドされている場合、上記の更新メソッドはすべて、下限または上限に達すると CounterOutOfBoundsException を出力します。例外には、どちら側にバインドが到達したかを確認するための次のメソッドがあります。

public boolean isUpperBoundReached(); public boolean isLowerBoundReached();

public boolean isUpperBoundReached();

public boolean isLowerBoundReached();10.3.1.2. ユースケース

強力なカウンターは、次の使用例に適しています。

- 各更新後にカウンターの値が必要な場合 (例: クラスター単位の ID ジェネレーターまたはシーケンス)

- バインドされたカウンターが必要な場合は (例: レートリミッター)

10.3.1.3. 使用例

以下に、バインドされたカウンターを使用する別の例を示します。

Compare-and-set と Compare-and-swap の比較例:

compare-and-swap では、呼び出しカウンターの呼び出し (counter.getValue()) が 1 つ保存されます。

10.3.2. WeakCounter インターフェイス: 速度が必要な場合

WeakCounter は、カウンターの値を Data Grid キャッシュの複数のキーに保存します作成されたキーの数は concurrency-level 属性によって設定されます。各キーはカウンターの値の一部の状態を保存し、同時に更新できます。StrongCounter よりも優れた点は、キャッシュの競合率が低いことです。一方、値の読み取りはよりコストが高く、バインドは許可されません。

リセット操作は注意して行う必要があります。これは アトミックではなく、中間値を生成します。これらの値は、読み取り操作および登録されたリスナーによって確認できます。

WeakCounter は、getWeakCounter() メソッドを使用して CounterManager から取得できます。たとえば、以下のようになります。

CounterManager counterManager = ...

StrongCounter aCounter = counterManager.getWeakCounter("my-counter);

CounterManager counterManager = ...

StrongCounter aCounter = counterManager.getWeakCounter("my-counter);10.3.2.1. weak カウンターインターフェイス

WeakCounter は、以下のメソッドを追加します。

これらは `StrongCounter のメソッドと似ていますが、新しい値は返されません。

10.3.2.2. ユースケース

weak カウンターは、更新操作の結果が必要ない場合やカウンターの値があまり必要でないユースケースに最適です。統計の収集は、このようなユースケースの良い例になります。

10.3.2.3. 例

以下では、弱いカウンターの使用例を示します。

10.4. 通知およびイベント

strong カウンターと weak カウンターの両方が、更新イベントを受信するためにリスナーをサポートします。リスナーは CounterListener を実装する必要があり、これを以下の方法で登録できます。

<T extends CounterListener> Handle<T> addListener(T listener);

<T extends CounterListener> Handle<T> addListener(T listener);

CounterListener には以下のインターフェイスがあります。

public interface CounterListener {

void onUpdate(CounterEvent entry);

}

public interface CounterListener {

void onUpdate(CounterEvent entry);

}

返される Handle オブジェクトには、CounterListener が必要なくなったときに削除するという主な目的があります。また、処理している CounterListener インスタンスにアクセスできます。これには、以下のインターフェイスがあります。

public interface Handle<T extends CounterListener> {

T getCounterListener();

void remove();

}

public interface Handle<T extends CounterListener> {

T getCounterListener();

void remove();

}

最後に、CounterEvent には、以前と現在の値と状態があります。これには、以下のインターフェイスがあります。

状態は、非有界である strong カウンターおよび weak カウンターでは常に State.VALID になります。State.LOWER_BOUND_REACHED および State.UPPER_BOUND_REACHED は有界である strong カウンターのみに有効です。

weak カウンター reset() 操作は、中間値で複数の通知をトリガーします。

第11章 ロックおよび同時実行

Data Grid は、マルチバージョン同時実行制御 (MVCC) を利用します (MVCC)。これは、リレーショナルデータベースや他のデータストアでよく使用される同時実行スキームです。MVCC には、粗粒度の Java 同期や、共有データにアクセスするための JDK ロックに比べて、次のような多くの利点があります。

- 同時リーダーとライターの許可

- リーダーとライターが互いにブロックしない

- 書き込みスキューを検出して処理できる

- 内部ロックのストライピングが可能

11.1. 実装の詳細のロック

Data Grid の MVCC 実装では、ロックと同期が最小限に抑えられており、可能な限り compare-and-swap などのロックフリー技術やロックフリーのデータ構造などに重点を置いています。これにより、マルチ CPU 環境とマルチコア環境の最適化に役立ちます。

特に、Data Grid の MVCC 実装はリーダーに対して高度に最適化されています。リーダースレッドは、エントリーの明示的なロックを取得せず、代わりに問題のエントリーを直接読み込みます。

一方、ライターは、書き込みロックを取得する必要があります。これにより、エントリーごとに 1 つの同時書き込みのみが保証されるため、同時ライターはキューイングしてエントリーを変更することになります。

同時読み取りを可能にするため、ライターはエントリーを MVCCEntry でラップして、変更する予定のエントリーのコピーを作成します。このコピーは、同時リーダーが部分的に変更された状態を認識できないようにします。書き込みが完了したら、MVCCEntry.commit() はデータコンテナーへの変更をフラッシュし、後続のリーダーに変更内容が反映されます。

11.1.1. クラスター化されたキャッシュでの仕組み

クラスター化されたキャッシュでは、各キーにキーをロックするノードがあります。このノードはプライマリー所有者と呼ばれます。

11.1.1.1. 非トランザクションキャッシュ

- 書き込み操作はキーのプライマリー所有者に送信されます。

プライマリー所有者はキーをロックしようとします。

- 成功すると、操作が他の所有者に転送されます。

- そうでない場合は、例外が発生します。

操作が条件付きで、プライマリーオーナーで失敗した場合、他のオーナーには転送されません。

操作がプライマリー所有者でローカルに実行される場合、最初のステップはスキップされます。

11.1.2. トランザクションキャッシュ

トランザクションキャッシュは、楽観的および悲観的ロックモードをサポートします。詳細は、トランザクションのロックを参照してください。

11.1.3. 分離レベル

分離レベルは、他のトランザクションと同時に実行されているときに読み取ることができるトランザクションに影響します。詳細は、分離レベルを参照してください。

11.1.4. LockManager

LockManager は、書き込み用にエントリーをロックするコンポーネントです。LockManager は、LockContainer を使用して、ロックを検索、保持、作成します。LockContainers には、ロックストライピングをサポートするものと、エントリーごとに 1 つのロックをサポートするものの 2 つの大まかな特徴があります。

11.1.5. ロックストライピング

ロックストライピングでは、固定サイズの共有ロックコレクションをキャッシュ全体に使用する必要があり、ロックはエントリーのキーのハッシュコードに基づいてエントリーに割り当てられます。JDK の ConcurrentHashMap がロックを割り当てる方法と同様に、これにより、関連性のない可能性のあるエントリーが同じロックによってブロックされる代わりに、拡張性の高い固定オーバーヘッドのロックメカニズムが可能になります。

別の方法は、ロックストライピングを無効にすることです。これは、エントリーごとに 新しい ロックが作成されることを意味します。このアプローチでは、スループットが高くなる 可能性 がありますが、追加のメモリー使用量やガベージコレクションのチャーンなどのコストがかかります。

異なるキーのロックが同じロックストライプになってしまうとデッドロックが発生する可能性があるため、ロックストライピングはデフォルトで無効になっています。

ロックストライピングで使用される共有ロックコレクションのサイズは、<locking /> 設定要素の concurrencyLevel 属性を使用して調整できます。

設定例:

<locking striping="false|true"/>

<locking striping="false|true"/>または、以下を実行します。

new ConfigurationBuilder().locking().useLockStriping(false|true);

new ConfigurationBuilder().locking().useLockStriping(false|true);11.1.6. 同時実行レベル

この同時実行レベルは、ストライプロックコンテナーのサイズを決定する他に、DataContainer の内部など、関連する JDK ConcurrentHashMap ベースのコレクションを調整するためにも使用されます。このパラメーターは、Data Grid でもまったく同じ方法で使用されているため、同時実行レベルの詳細については、JDK ConcurrentHashMap Javadocs を参照してください。

設定例:

<locking concurrency-level="32"/>

<locking concurrency-level="32"/>または、以下を実行します。

new ConfigurationBuilder().locking().concurrencyLevel(32);

new ConfigurationBuilder().locking().concurrencyLevel(32);11.1.7. ロックタイムアウト

ロックタイムアウトは、競合するロックを待つ時間 (ミリ秒単位) を指定します。

設定例:

<locking acquire-timeout="10000"/>

<locking acquire-timeout="10000"/>または、以下を実行します。

new ConfigurationBuilder().locking().lockAcquisitionTimeout(10000); //alternatively new ConfigurationBuilder().locking().lockAcquisitionTimeout(10, TimeUnit.SECONDS);

new ConfigurationBuilder().locking().lockAcquisitionTimeout(10000);

//alternatively

new ConfigurationBuilder().locking().lockAcquisitionTimeout(10, TimeUnit.SECONDS);11.1.8. 一貫性

(すべての所有者がロックされているのとは対照的に) 単一の所有者がロックされるという事実により、次の一貫性の保証が失われることはありません。キー K がノード {A, B} に対してハッシュ化され、トランザクション TX1 が、たとえば、A 上の K のロックを取得したとします。別のトランザクション TX2 が B (またはその他のノード) 上で開始され、TX2 が K のロックを試みる場合、ロックがすでに TX1 によって保持されているため、タイムアウトでロックに失敗します。理由は、キー K のロックがトランザクションの発生場所に関係なく、常に、確定的に、クラスターの同じノードで取得されるからです。

11.2. データのバージョン管理

Data Grid は、simple と external の 2 つの形式のデータバージョン管理をサポートします。simple バージョン管理は、書き込みスキューチェックのトランザクションキャッシュで使用されます。

external バージョン管理は、Data Grid を Hibernate で使用する場合など、Data Grid 内のデータバージョン管理の外部ソースをカプセル化するために使用され、そのデータバージョン情報をデータベースから直接取得します。

このスキームでは、バージョンに渡すメカニズムが必要になり、オーバーロードされたバージョン put() および putForExternalRead() が、AdvancedCache で提供され、外部データバージョンを取り込みます。その後、これは InvocationContext に保管され、コミット時にエントリーに適用されます。

external バージョン管理の場合、書き込みスキューチェックは実行できず、実行されません。

第12章 Data Grid CDI エクステンションの使用

Data Grid は、CDI (Contexts and Dependency Injection) プログラミングモデルと統合し、以下を可能にするエクステンションを提供します。

- CDI Bean および Java EE コンポーネントにキャッシュを設定し、インジェクトします。

- キャッシュマネージャーを設定します。

- キャッシュおよびキャッシュマネージャーレベルのイベントを受信します。

- JCache アノテーションを使用してデータストレージおよび取得を制御します。

12.1. CDI 依存関係

以下の依存関係のいずれかで pom.xml を更新し、プロジェクトに Data Grid CDI エクステンションを追加します。

埋め込み (Library) モード

<dependency> <groupId>org.infinispan</groupId> <artifactId>infinispan-cdi-embedded</artifactId> </dependency>

<dependency>

<groupId>org.infinispan</groupId>

<artifactId>infinispan-cdi-embedded</artifactId>

</dependency>サーバーモード

<dependency> <groupId>org.infinispan</groupId> <artifactId>infinispan-cdi-remote</artifactId> </dependency>

<dependency>

<groupId>org.infinispan</groupId>

<artifactId>infinispan-cdi-remote</artifactId>

</dependency>12.2. 組み込みキャッシュのインジェクト

組み込みキャッシュをインジェクトするために CDI Bean を設定します。

手順

キャッシュ修飾子アノテーションを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

@GreetingCache修飾子を作成します。

キャッシュ設定を定義するプロデューサーメソッドを追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 必要に応じて、クラスター化されたキャッシュマネージャーを作成するプロデューサーメソッドを追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記キャッシュマネージャーは、ヘビーウェイトオブジェクトです。アプリケーションで複数のキャッシュマネージャーを実行すると、パフォーマンスが低下する可能性があります。複数のキャッシュを挿入する場合は、各キャッシュの修飾子をキャッシュマネージャープロデューサーメソッドに追加するか、修飾子を追加しないでください。

@GreetingCache修飾子をキャッシュインジェクションポイントに追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

12.3. リモートキャッシュの注入

リモートキャッシュを注入するために CDI Bean を設定します。

手順

キャッシュ修飾子アノテーションを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow キャッシュインジェクションポイントに

@RemoteGreetingCache修飾子を追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

リモートキャッシュをインジェクトするためのヒント

修飾子を使用せずにリモートキャッシュをインジェクトできます。

... @Inject @Remote("greetingCache") private RemoteCache<String, String> cache;... @Inject @Remote("greetingCache") private RemoteCache<String, String> cache;Copy to Clipboard Copied! Toggle word wrap Toggle overflow 複数の Data Grid クラスターがある場合は、クラスターごとに個別のリモートキャッシュマネージャープロデューサーを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

12.4. JCache キャッシングアノテーション

JCache アーティファクトがクラスパスにある場合、以下の JCache キャッシングアノテーションを CDI 管理 Bean で使用できます。

@CacheResult- メソッド呼び出しの結果をキャッシュします。

@CachePut- メソッドパラメーターをキャッシュします。

@CacheRemoveEntry- キャッシュからエントリーを削除します。

@CacheRemoveAll- キャッシュからすべてのエントリーを削除します。

Target type: これらの JCache キャッシングアノテーションはメソッドでのみ使用できます。

JCache キャッシュアノテーションを使用するには、アプリケーションの beans.xml ファイルでインターセプターを宣言します。

管理対象環境 (アプリケーションサーバー)

管理対象外環境 (スタンドアロン)

JCache キャッシングアノテーションの例

以下の例は、@CacheResult アノテーションが GreetingService.greet() メソッドの結果をキャッシュする方法を示しています。

JCache アノテーションを使用すると、デフォルトのキャッシュは、アノテーションが付けられたメソッドの完全修飾名をパラメータータイプで使用します (例:

org.infinispan.example.GreetingService.greet(java.lang.String))。

デフォルト以外のキャッシュを使用するには、以下の例のように、cacheName 属性を使用してキャッシュ名を指定します。

@CacheResult(cacheName = "greeting-cache")

@CacheResult(cacheName = "greeting-cache")12.5. キャッシュおよびキャッシュマネージャーイベントの受信

CDI イベントを使用して、キャッシュおよびキャッシュマネージャーレベルのイベントを受信します。

-

以下の例のように

@Observesアノテーションを使用します。

第13章 Data Grid トランザクション

Data Grid は、JTA 準拠のトランザクションを使用し、参加するように設定できます。

または、トランザクションのサポートが無効になっている場合は、JDBC 呼び出しで自動コミットを使用する場合と同等になります。ここでは、すべての変更後に変更がレプリケートされる可能性があります (レプリケーションが有効な場合)。

すべてのキャッシュ操作で Data Grid は以下を行います。

- スレッドに関連する現在の トランザクション を取得します。

- トランザクションのコミットまたはロールバック時に通知されるように、XAResource をトランザクションマネージャーに登録します (登録されていない場合)。

これを実行するには、キャッシュに環境の TransactionManager への参照を提供する必要があります。これは通常、TransactionManagerLookup インターフェイスの実装のクラス名を使用してキャッシュを設定することで行います。キャッシュが起動すると、このクラスのインスタンスを作成し、TransactionManager への参照を返す getTransactionManager() メソッドを呼び出します。

Data Grid には複数のトランザクションマネージャールックアップクラスが同梱されます。

トランザクションマネージャールックアップの実装

- EmbeddedTransactionManagerLookup: これは、他の実装が利用できない場合に、埋め込みモードのみに使用する必要がある基本的なトランザクションマネージャーを提供します。この実装は、同時トランザクションおよびリカバリーでは、重大な制限があります。

-

JBossStandaloneJTAManagerLookup: スタンドアロン環境、または JBoss AS 7 以前、および WildFly 8、9、10 で Data Grid を実行している場合、トランザクションマネージャーのデフォルトとしてこれを選択します。このトランザクションは、

EmbeddedTransactionManagerの不足をすべて解消する JBoss Transactions をベースとした本格的なトランザクションマネージャーです。 - WildflyTransactionManagerLookup: WildFly 11 以降で Data Grid を実行している場合は、トランザクションマネージャーのデフォルトとしてこれを選択します。

-

GenericTransactionManagerLookup: これは、最も一般的な Java EE アプリケーションサーバーでトランザクションマネージャーを見つけるルックアップクラスです。トランザクションマネージャーが見つからない場合は、

EmbeddedTransactionManagerがデフォルトの設定になります。

警告: DummyTransactionManagerLookup は 9.0 で非推奨となり、今後削除される予定です。代わりに EmbeddedTransactionManagerLookup を使用してください。

初期化すると、TransactionManager は Cache 自体から取得することもできます。

//the cache must have a transactionManagerLookupClass defined Cache cache = cacheManager.getCache(); //equivalent with calling TransactionManagerLookup.getTransactionManager(); TransactionManager tm = cache.getAdvancedCache().getTransactionManager();

//the cache must have a transactionManagerLookupClass defined

Cache cache = cacheManager.getCache();

//equivalent with calling TransactionManagerLookup.getTransactionManager();

TransactionManager tm = cache.getAdvancedCache().getTransactionManager();13.1. トランザクションの設定

トランザクションはキャッシュレベルで設定されます。以下はトランザクションの動作に影響する設定と、各設定属性の簡単な説明になります。

プログラムを使用する場合

-

isolation- 分離レベルを設定します。詳細は、分離レベル を参照してください。デフォルトはREPEATABLE_READです。 -

locking- キャッシュが楽観的または悲観的ロックを使用するかどうかを設定します。詳細は、トランザクションのロック を参照してください。デフォルトはOPTIMISTICです。 -

auto-commit: 有効にすると、ユーザーは 1 回の操作でトランザクションを手動で開始する必要はありません。トランザクションは自動的に起動およびコミットされます。デフォルトはtrueです。 -

complete-timeout- 完了したトランザクションに関する情報を保持する期間 (ミリ秒単位)。デフォルトは60000です。 mode: キャッシュがトランザクションかどうかを設定します。デフォルトはNONEです。利用可能なオプションは以下のとおりです。-

NONE- 非トランザクションキャッシュ -

FULL_XA- リカバリーが有効になっている XA トランザクションキャッシュリカバリーの詳細は、トランザクションリカバリー を参照してください。 -

NON_DURABLE_XA- リカバリーが無効になっている XA トランザクションキャッシュ。 -

NON_XA- XA の代わりに 同期化 を介して統合されたトランザクションキャッシュ。詳細は、同期の登録 のセクションを参照してください。 -

BATCH- バッチを使用して操作をグループ化するトランザクションキャッシュ。詳細は バッチ処理 のセクションを参照してください。

-

-

notifications- キャッシュリスナーのトランザクションイベントを有効/無効にします。デフォルトはtrueです。 protocol- プロトコルが使用するように設定します。デフォルトはDEFAULTです。使用できる値は次のとおりです。-

DEFAULT- 従来の 2 フェーズコミットプロトコルを使用します。以下で説明します。 -

TOTAL_ORDER:トランスポートによって保証された合計順序を使用してトランザクションをコミットします。詳細は Total Order based commit protocol のセクションを参照してください。

-

-

reaper-interval- トランザクション完了情報をクリーンアップするスレッドが開始する間隔 (ミリ秒単位)。デフォルトは30000です。 -

recovery-cache- リカバリー情報を保存するキャッシュ名を設定します。リカバリーの詳細は、トランザクションリカバリー を参照してください。デフォルトはrecoveryInfoCacheNameです。 -

stop-timeout- キャッシュの停止時に進行中のトランザクションを待機する時間 (ミリ秒単位)。デフォルトは30000です。 -

transaction-manager-lookup-javax.transaction.TransactionManagerへの参照を検索するクラスの完全修飾クラス名を設定します。デフォルトはorg.infinispan.transaction.lookup.GenericTransactionManagerLookupです。

2 フェーズコミット (2PC) が Data Grid に実装される方法、およびロックが取得される方法についての詳細は、以下のセクションを参照してください。設定の詳細については、設定リファレンス を参照してください。

13.2. 分離レベル

Data Grid は、READ_COMMITTED および REPEATABLE_READ の 2 つの分離レベルを提供します。

これらの分離レベルは、リーダーが同時書き込みを確認するタイミングを決定し、MVCCEntry の異なるサブクラスを使用して内部的に実装されます。MVCCEntry では、状態がデータコンテナーにコミットされる方法が異なります。

以下は、Data Grid のコンテキストの READ_COMMITTED および REPEATABLE_READ の違いを理解する上で役立つ詳細な例です。READ_COMMITTED の場合、同じキーで連続して 2 つの読み取り呼び出しを行うと、キーが別のトランザクションによって更新され、2 つ目の読み取りによって新しい更新値が返されることがあります。

REPEATABLE_READ では、最終 get は引き続き v を返します。そのため、トランザクション内で同じキーを複数回取得する場合は、REPEATABLE_READ を使用する必要があります。

ただし、読み取りロックが REPEATABLE_READ に対しても取得されないため、この現象が発生する可能性があります。

13.3. トランザクションのロック

13.3.1. 悲観的なトランザクションキャッシュ

ロック取得の観点では、悲観的トランザクションはキーの書き込み時にキーのロックを取得します。

- ロック要求がプライマリー所有者に送信されます (明示的なロック要求または操作のいずれか)。

プライマリーの所有者はロックの取得を試みます。

- 成功した場合は、正の応答が返されます。

- そうでない場合は、負の応答が送信され、トランザクションはロールバックされます。

たとえば、以下のようになります。

transactionManager.begin(); cache.put(k1,v1); //k1 is locked. cache.remove(k2); //k2 is locked when this returns transactionManager.commit();

transactionManager.begin();

cache.put(k1,v1); //k1 is locked.

cache.remove(k2); //k2 is locked when this returns

transactionManager.commit();

cache.put(k1,v1) が返されると、k1 はロックされ、クラスター内のどこかで実行中の他のトランザクションは、これに書き込むことができません。k1 の読み取りは引き続き可能です。トランザクションの完了時に k1 のロックが解放されます (コミットまたはロールバック)。

条件付き操作の場合、検証はオリジネーターで実行されます。

13.3.2. 楽観的トランザクションキャッシュ

楽観的トランザクションロックはトランザクションの準備時に取得され、トランザクションのコミット (またはロールバック) まで保持されます。これは、書き込みでローカルロックを取得し、準備中にクラスターのロックが取得される 5.0 デフォルトロックモデルとは異なります。

- 準備はすべての所有者に送信されます。

プライマリーの所有者は、必要なロックの取得を試みます。

- ロックに成功すると、書き込みのスキューチェックが実行されます。

- 書き込みスキューチェックが成功した場合 (または無効化された場合) は、正の応答を送信します。

- それ以外の場合は、負の応答が送信され、トランザクションはロールバックされます。

たとえば、以下のようになります。

transactionManager.begin(); cache.put(k1,v1); cache.remove(k2); transactionManager.commit(); //at prepare time, K1 and K2 is locked until committed/rolled back.

transactionManager.begin();

cache.put(k1,v1);

cache.remove(k2);

transactionManager.commit(); //at prepare time, K1 and K2 is locked until committed/rolled back.条件付きコマンドの場合、検証は引き続きオリジネーターで実行されます。

13.3.3. 悲観的または楽観的トランザクションのどちらが必要か

ユースケースの観点からは、同時に実行されている複数のトランザクション間で多くの競合が ない 場合は、楽観的トランザクションを使用する必要があります。これは、読み取り時と、コミット時 (書き込みスキューチェックが有効) の間でデータが変更された場合に、楽観的トランザクションがロールバックするためです。

一方、キーでの競合が多く、トランザクションのロールバックがあまり望ましくない場合は、悲観的トランザクションの方が適している可能性があります。悲観的トランザクションは、その性質上、よりコストがかかります。各書き込み操作ではロックの取得に RPC が関係する可能性があります。

13.4. スキューの書き込み

書き込みスキューは、2 つのトランザクションが独立して同時に同じキーの読み取りと書き込みを行うときに発生します。書き込みスキューの結果、両方のトランザクションは同じキーに対して更新を正常にコミットしますが、値は異なります。

Data Grid は、書き込みスキューチェックを自動的に実行し、楽観的トランザクションで REPEATABLE_READ 分離レベルのデータの一貫性を確保します。これにより、Data Grid はトランザクションの 1 つを検出し、ロールバックできます。

LOCAL モードで動作する場合、書き込みスキューの確認は Java オブジェクト参照に依存して違いを比較します。これにより、書き込みスキューをチェックするための信頼性の高い技術が提供されます。

13.4.1. 悲観的トランザクションでのキーへの書き込みロックの強制

悲観的トランザクションでの書き込みスキューを回避するには、Flag.FORCE_WRITE_LOCK で読み取り時にキーをロックします。

-

トランザクション以外のキャッシュでは、

Flag.FORCE_WRITE_LOCKは動作しません。get()呼び出しは、キーの値を読み取りますが、ロックをリモートで取得しません。 -

Flag.FORCE_WRITE_LOCKは、同じトランザクションでエンティティーが後で更新されるトランザクションと併用する必要があります。

Flag.FORCE_WRITE_LOCK の例については、以下のコードスニペットを比較してください。

13.5. 例外への対処

CacheException (またはそのサブクラス) が JTA トランザクションの範囲内のキャッシュメソッドによって出力される場合、トランザクションは自動的にロールバックに対してマークされます。

13.6. 同期の登録

デフォルトでは、Data Grid は XAResource を介して、分散トランザクションの最初のクラス参加者として登録します。トランザクションの参加者として Data Grid が必要ではなく、ライフサイクル (準備、完了) によってのみ通知される状況があります (例: Data Grid が Hibernate で 2 次レベルキャッシュとして使用される場合など)。

Data Grid は、同期 を介したトランザクションのエンリストを許可します。これを有効にするには、NON_XA トランザクションモードを使用します。

Synchronization には、TransactionManager が 1PC で 2PC を最適化できるという利点があります。この場合、他の 1 つのリソースのみがそのトランザクションにエンリストされます (last resource commit optimization)。つまり、Hibernate 2 次キャッシュ: Data Grid がコミット時よりも XAResource として TransactionManager に登録する場合、TransactionManager は 2 つの XAResource (キャッシュとデータベース) を認識し、この最適化を行いません。2 つのリソース間で調整する必要があるため、tx ログをディスクに書き込む必要があります。一方、Data Grid を Synchronization として登録すると、TransactionManager はディスクへのログの書き込みを省略します (パフォーマンスが向上)。

13.7. バッチ処理

バッチ処理は、トランザクションの原子性といくつかの特性を許可しますが、本格的な JTA または XA 機能は許可しません。多くの場合、バッチ処理は本格的なトランザクションよりもはるかに軽量で安価です。

一般的には、トランザクションの参加者のみが Data Grid クラスターである場合に、バッチ処理 API を使用する必要があります。反対に、トランザクションに複数のシステムが必要な場合に、(TransactionManager に関連する)JTA トランザクションを使用する必要があります。たとえば、トランザクションの Hello world! を考慮すると、ある銀行口座から別の銀行口座にお金を転送します。両方の口座が Data Grid 内に保存されている場合は、バッチ処理を使用できます。ある口座がデータベースにあり、もう 1 つの口座が Data Grid の場合は、分散トランザクションが必要になります。

バッチ処理を使用するためにトランザクションマネージャーを定義する必要はありません。

13.7.1. API

バッチ処理を使用するようにキャッシュを設定したら、Cache で startBatch() と endBatch() を呼び出して使用します。例:

13.7.2. バッチ処理と JTA

裏では、バッチ機能が JTA トランザクションを開始し、そのスコープ内のすべての呼び出しがそれに関連付けられます。これには、内部 TransactionManager 実装が非常に簡単な (例: リカバリーなし) を使用します。バッチ処理では、以下を取得します。

- 呼び出し中に取得したロックはバッチが完了するまで保持されます。

- 変更はすべて、バッチ完了プロセスの一部として、クラスター内でバッチ内に複製されます。バッチの各更新のレプリケーションチャット数を減らします。

- 同期のレプリケーションまたは無効化が使用された場合は、レプリケーション/無効化の失敗により、バッチがロールバックされます。

- すべてのトランザクション関連の設定は、バッチ処理にも適用されます。

13.8. トランザクションリカバリー

リカバリーは XA トランザクションの機能であり、リソースの不測の事態、場合によってはトランザクションマネージャーの障害を対処し、それに応じてそのような状況から回復します。

13.8.1. リカバリーを使用するタイミング

外部データベースに保存されたアカウントから Data Grid に保管されたアカウントに転送される分散トランザクションについて考えてみましょう。TransactionManager.commit() が呼び出されると、両方のリソースが正常に完了します (第 1 フェーズ)。コミット (第 2) フェーズでは、データベースは、トランザクションマネージャーからコミットリクエストを受け取る前に、Data Grid の変更を問題なく適用します。この時点では、システムが一貫性のない状態です。お金は外部データベースのア口座から取得されますが、まだ Data Grid には表示されません (ロックは 2 フェーズコミットプロトコルの 2 番目のフェーズでのみリリースされます)。リカバリーはこの状況に対応することで、データベースと Data Grid の両方のデータが一貫した状態で終了します。

13.8.2. 仕組み

リカバリーはトランザクションマネージャーによって調整されます。トランザクションマネージャーは Data Grid と連携して、手動による介入が必要な未確定のトランザクションのリストを決定し、システム管理者に (電子メール、ログアラートなどを介して) 通知します。このプロセスはトランザクションマネージャーに固有のものですが、通常トランザクションマネージャーで設定が必要になります。

未確定のトランザクション ID を把握すると、システム管理者は Data Grid クラスターに接続し、トランザクションのコミットを再生したり、ロールバックを強制できるようになりました。Data Grid は、この JMX ツールを提供します。これは、トランザクションのリカバリーおよび調整セクション で広範囲に説明されています。

13.8.3. リカバリーの設定

Data Grid では、リカバリーはデフォルトでは有効になっていません。無効にすると、TransactionManager は Data Grid と動作しないため、インダウト状態のトランザクションを決定できません。トランザクションの設定 セクションでは、その設定を有効にする方法を示しています。

注記: recovery-cache 属性は必須ではなく、キャッシュごとに設定されます。

リカバリーが機能するには、完全な XA トランザクションが必要であるため、mode を FULL_XA に設定する必要があります。

13.8.3.1. JMX サポートの有効化

リカバリー JMX サポートの管理に JMX を使用できるようにするには、明示的に有効にする必要があります。

13.8.4. リカバリーキャッシュ

未確定のトランザクションを追跡し、それらに応答できるようにするために、Data Grid は将来の使用のためにすべてのトランザクション状態をキャッシュします。この状態は、未確定のトランザクションに対してのみ保持され、コミット/ロールバックフェーズが完了した後、正常に完了したトランザクションに対しては削除されます。

この未確定のトランザクションデータはローカルキャッシュ内に保持されます。これにより、データが大きくなりすぎた場合に、キャッシュローダーを介してこの情報をディスクにスワップするように設定できます。このキャッシュは、recovery-cache 設定属性を介して指定できます。指定のない場合は、Data Grid がローカルキャッシュを設定します。

リカバリーが有効になっているすべての Data Grid キャッシュ間で同じリカバリーキャッシュを共有することは可能です (必須ではありません)。デフォルトのリカバリーキャッシュが上書きされた場合、指定のリカバリーキャッシュは、キャッシュ自体が使用するものとは異なるトランザクションマネージャーを返す TransactionManagerLookup を使用する必要があります。

13.8.5. トランザクションマネージャーとの統合

これはトランザクションマネージャーに固有のものですが、通常トランザクションマネージャーは XAResource.recover() を呼び出すために XAResource 実装への参照が必要になります。Data Grid XAResource の以下の API への参照を取得するには、以下を行います。

XAResource xar = cache.getAdvancedCache().getXAResource();

XAResource xar = cache.getAdvancedCache().getXAResource();トランザクションを実行するプロセスとは異なるプロセスで復元を実行することが一般的です。

13.8.6. 調整

トランザクションマネージャーは、システム管理者に未確定のトランザクションについて独自の方法で通知します。この段階では、システム管理者がトランザクションの XID(バイトアレイ) を把握していることを前提としています。

通常のリカバリーフローは以下のとおりです。

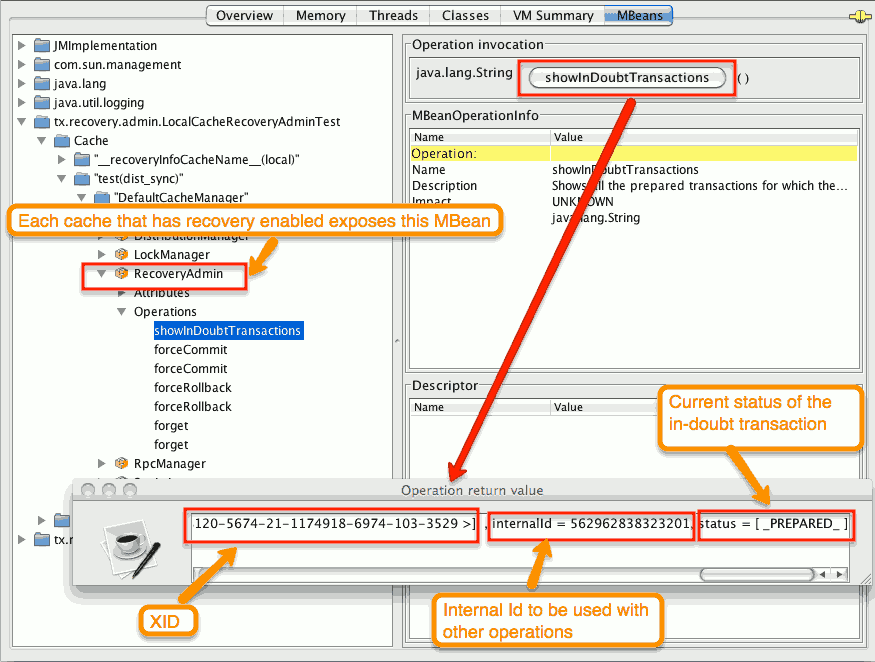

- ステップ 1: システム管理者は、JMX を介して Data Grid サーバーに接続し、未確定のトランザクションを一覧表示します。以下のイメージは、未確定のトランザクションを持つ Data Grid ノードに接続する JConsole を示しています。

図13.1 未確定のトランザクションの表示

未確定の各トランザクションのステータスが表示されます (この例では PREPARED です)。status フィールドに複数の要素が存在する可能性があります。たとえば、トランザクションが特定ノードでコミットされていても、それらのノードでコミットされない場合は PREPARED および COMMITTED です。

- ステップ 2: システム管理者は、トランザクションマネージャーから受け取った XID を数字で表した Data Grid 内部 ID に視覚的にマッピングします。XID(バイトアレイ) は、JMX ツール (JConsole など) に渡して Data Grid 側で再アセンブルされるため、このステップが必要です。

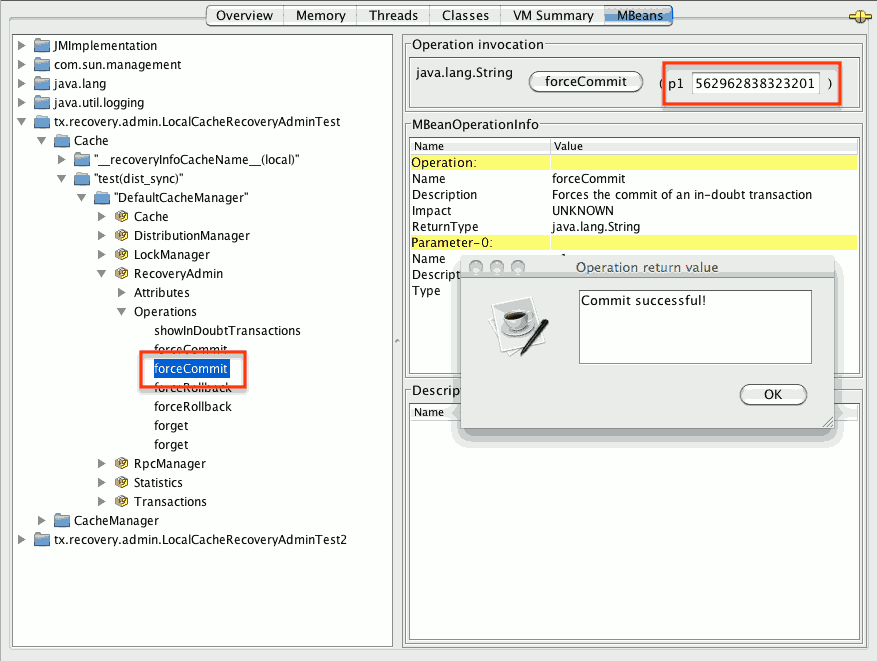

- ステップ 3: システム管理者は、内部 ID に基づいて、対応する jmx 操作を介してトランザクションのコミット/ロールバックを強制的に実行します。以下のイメージは、内部 ID に基づいてトランザクションのコミットを強制することで取得します。

図13.2 コミットの強制

上記のすべての JMX 操作は、トランザクションの発信場所に関係なく、任意のノードで実行できます。

13.8.6.1. XID に基づくコミット/ロールバックの強制

未確定のトランザクションのコミット/ロールバックの強制を行う XID ベースの JMX 操作も使用できます。これらのメソッドはトランザクションに関連する番号ではなく、XID を記述する byte[] アレイを受け取ります (前述のステップ 2 で説明)。これらは、たとえば、特定の未確定トランザクションの自動完了ジョブを設定する場合に役立ちます。このプロセスはトランザクションマネージャーのリカバリーにプラグインされ、トランザクションマネージャーの XID オブジェクトにアクセスできます。

13.8.7. 詳細

リカバリー設計ドキュメント では、トランザクションリカバリー実装の内部について詳しく説明しています。

13.9. Total Order ベースのコミットプロトコル

Total Order ベースのプロトコルは、マルチマスタースキーム (このコンテキストでは、マルチマスタースキームは、すべてのノードが Data Grid に実装された (optimistic/pessimist) ロックモードとしてすべてのデータを更新できることを意味します) です。このコミットプロトコルは、メッセージの完全な順序付けされた配信の概念に依存します。これは、メッセージのセットを提供する各ノードが同じ順序で配信されることを意味します。

このプロトコルには、この利点があります。

- トランザクションは、それらを受信するノードによって同じ順序で配信されるため、1 つのフェーズでコミットできます。

- 分散のデッドロックを軽減します。

このアプローチの弱点は、その実装は、トランザクションとその変更を提供するノードごとに単一のスレッドに依存し、Transport でメッセージを完全に順序付けする若干のコストです。

したがって、このプロトコルは 競合が高い シナリオで最高のパフォーマンスを提供します。これは、シングルフェーズコミットを活用でき、配信スレッドはボトルネックではありません。

現在、Total Order ベースのプロトコルは、replicated および distributed モードの トランザクション キャッシュでのみ利用できます。

13.9.1. 概要

Total Order ベースのコミットプロトコルは、トランザクションが Data Grid によってコミットされる方法と、分離レベルと書き込みスキューが動作に影響する方法にのみ影響します。

書き込みスキューが無効になっていると、トランザクションは単一のフェーズでコミット/ロールバックできます。データの整合性は Transport によって保証され、キーのすべての所有者が同じ順序で設定された同じトランザクションを提供します。

一方、書き込みスキューを有効にすると、プロトコルは適合し、安全であれば 1 フェーズコミットを使用します。XaResource enlistment では、TransactionManager が 1 つのフェーズでコミットを要求し (最後のリソースコミットの最適化)、Data Grid キャッシュがレプリケートモードで設定されている場合に 1 つのフェーズを使用できます。各ノードが異なるキーサブセットで書き込みスキューチェック検証を実行するため、分散モードではこの最適化は安全ではありません。Synchronization enlistment では、Data Grid が唯一のリソースエンリストされたリソース (最後のリソースコミットの最適化) である場合、TransactionManager は情報を提供しないため、1 つのフェーズでコミットすることはできません。

13.9.1.1. 1 つのフェーズでのコミット

トランザクションが終了すると、Data Grid はトランザクション (およびその変更) を合計順に送信します。これにより、関連するすべての Data Grid ノードですべてのトランザクションが同じ順序で配信されます。その結果、トランザクションが配信されると、同じ状態 (有効な場合) で決定的な書き込みスキューチェックが実行され、同じ結果 (トランザクションのコミットまたはロールバック) が発生します。

図13.3 1 フェーズコミット

上の図は、3 つのノードがある高レベルの例を示しています。Node1 と Node3 はそれぞれ 1 つのトランザクションを実行しており、両方のトランザクションが同じキーに書き込むことを想定できます。より興味深いものにするために、図の最初の色付きの円で表される、両方のノードが同時にコミットしようとすると仮定します。青い 円はトランザクション tx1、緑 はトランザクション tx2 を表しています。どちらのノードも、トランザクションの変更とともに、合計順序でリモート呼び出しを実行します(to-send)。この時点で、すべてのノードが同じ配信順序で同意します (例: tx1 の後に tx2 が続きます)。次に、各ノードは tx1 を提供し、検証を実行し、変更をコミットします。tx2 についても同じステップが実行されますが、この場合検証に失敗し、トランザクションは関係するすべてのノードでロールバックされます。

13.9.1.2. 2 つのフェーズでのコミット

最初のフェーズでは、合計順に変更を送信し、書き込みスキューチェックが実行されます。書き込みスキューチェックの結果は、発信者に返されます。すべてのキーが正常に検証されたことを確認するとすぐに、TransactionManager に正の応答が付与されます。一方、負の応答を受信すると、TransactionManager に負の応答が返されます。最後に、トランザクションは TransactionManager リクエストに応じて 2 番目のフェーズでコミットまたは中止されます。

図13.4 2 フェーズコミット

上の図は、最初の図で説明したシナリオを示していますが、2 つのフェーズを使用してトランザクションをコミットします。tx1 が配信されると検証が実行され、TransactionManager に応答します。次に、TransactionManager が tx1 の 2 番目のフェーズをリクエストする前に、tx2 が配信されると仮定します。この場合、tx2 はキューに入れられ、tx1 が完了した場合にのみ検証されます。最終的に、tx1 の TransactionManager は 2 番目のフェーズ(コミット)を要求し、すべてのノードが tx2 の検証を自由に実行できます。

13.9.1.3. トランザクションリカバリー

現在、トランザクションリカバリー は Total Order ベースのコミットプロトコルでは使用できません。

13.9.1.4. 状態遷移

簡略化のため、Total Order ベースコミットプロトコルは、現在の状態遷移のブロッキングバージョンを使用しています。主な相違点は以下のとおりです。

- 状態遷移中にトランザクションを配信します。

-

状態遷移制御メッセージ(

CacheTopologyControlCommand)は、合計順序で送信されます。

これにより、状態遷移と、すべてのノードであるトランザクション配信間の同期が可能になります。ただし、新しい参加者に関連する新しい合計順序を見つけるには、トランザクションは状態遷移の開始前に送信され(つまり、状態遷移の開始後に送信される)再送信する必要があります。

図13.5 トランザクション中のノード参加

上の図は、ノードの参加 を示しています。シナリオでは、tx2 は topologyId=1 で送信されますが、受信時に topologyId=2 にあります。そのため、トランザクションは新規ノードに関連する再送信されます。

13.9.2. 設定

キャッシュで total order を使用するには、jgroups.xml 設定ファイルに TOA プロトコルを追加する必要があります。

jgroups.xml

<tom.TOA />

<tom.TOA />詳細は JGroups Manual を参照してください。

JGroups が total order を保証する方法の詳細は、link::http://jgroups.org/manual/index.html#TOA[TOA manual] を確認してください。

また、トランザクション設定 に示すように、<transaction> 要素に protocol=TOTAL_ORDERを設定する必要があります。

13.9.3. いつ使用するか?

Total order は、書き込み集約型およびコンテンツ化されたワークロードで使用される利点を示します。ロックキーの競合を回避します。

第14章 インデックスとクエリー

14.1. 概要

Data Grid は、メインの Map のような API を補完する強力な検索 API を使用して、グリッドに保存されている Protocol Buffers を介してエンコードされた Java Pojo またはオブジェクトのインデックス作成と検索をサポートします。

クエリーはライブラリーモードとクライアント/サーバーモード(Java、C#、Node.js、その他のクライアントの場合) の両方で可能であり、DataGrid は ApacheLucene を使用してデータをインデックス化でき、広い範囲のデータ取得ユースケースをカバーするために効率的なフルテキスト対応の検索エンジンを提供します。

インデックス設定はスキーマ定義に依存し、Data Grid はライブラリーモードの場合はアノテーション付き Java クラスを使用でき、他の言語で書かれたリモートクライアントには protobuf スキーマを使用できます。protobuf で標準化することで、Data Grid は Java クライアントと 非 Java クライアントとの間の完全な相互運用性を可能にします。

インデックス付きクエリーとは別に、Data Grid はインデックス化されていないデータまたは部分的にインデックス化されたデータでクエリーを実行できます。

Search API の観点では、Data Grid には、文字列ベースである Ickle と呼ばれる独自のクエリー言語があり、完全なテキストクエリーのサポートが追加されました。Query DSL は、フルテキストが必要ない場合に埋め込みおよびリモート java クライアントの両方に使用できます。Java 埋め込みクライアント Data Grid は、Faceted や Spatial 検索などの高度な検索機能とは別に、グリッドでの Lucene クエリーの実行をサポートする Hibernate Search Query API を提供します。

最後に、Data Grid は 継続的なクエリー をサポートします。これは、他の API とは逆に動作します。クエリーの作成、クエリーの実行、結果の取得の代わりに、クライアントは、クラスター内のデータの変更に応じて継続的に評価されるクエリーを登録でき、変更されたデータがクエリーと一致するたびに通知を生成します。

14.2. 埋め込みクエリー

Data Grid をライブラリーとして使用すると、埋め込みクエリーを使用できます。protobuf マッピングは不要であり、インデックス作成と検索の両方が Java オブジェクト上で実行されます。ライブラリーモードでは、Lucene クエリーを直接実行し、利用可能なすべての Query API を使用できます。また、柔軟なインデックス設定により、レイテンシーを最小限に抑えることができます。

14.2.1. 簡単な例

books と呼ばれる Data Grid キャッシュに Book インスタンスを保存します。Book インスタンスはインデックス化されるため、キャッシュのインデックスを有効にし、Data Grid が インデックスを自動的に設定 できるようにします。

Data Grid の設定:

infinispan.xml

キャッシュを取得します。

各 Book は、次の例のように定義されます。インデックスを作成するプロパティーを選択する必要があります。プロパティーごとに、Hibernate Search プロジェクトで定義されたアノテーションを使用して高度なインデックスオプションを任意で選択できます。

Book.java

Author.java

public class Author {

@Field String name;

@Field String surname;

// hashCode() and equals() omitted

}

public class Author {

@Field String name;

@Field String surname;

// hashCode() and equals() omitted

}Data Grid Cache に複数の Book インスタンスを保存したとすると、次の例のように、一致するフィールドを検索できます。

Lucene クエリーの使用:

Lucene クエリーは、"title:infinispan AND authors.name:sanne" などのテキスト形式でクエリーを解析するか、Hibernate Search によって提供されるクエリービルダーを使用して作成されます。

list() とは別に、結果をストリーミングするか、ページネーションを使用できます。

Lucene またはフルテキスト機能を必要としない検索で、ほとんどの場合集計と完全一致に関するものである場合は、Data Grid Query DSL API を使用できます。

最後に、Ickle クエリーを直接使用して、1 つ以上の述語で Lucene 構文を可能にします。

14.2.2. インデックス化

Data Grid のインデックス作成はキャッシュごとに行われ、デフォルトではキャッシュはインデックス化されません。インデックスを有効にすることは必須ではありませんが、インデックスを使用したクエリーのパフォーマンスは大幅に高くなります。一方、インデックスを有効にするとクラスターの書き込みスループットに悪影響を及ぼす可能性があるため、一部のストラテジーの クエリーパフォーマンスガイド を確認して、キャッシュタイプとユースケースに応じてこの影響を最小限に抑えるようにしてください。

14.2.2.1. 設定

14.2.2.1.1. 一般的な形式

XML によるインデックス作成を有効にするには、<indexing> 要素と index (インデックスモード) をキャッシュ設定に追加し、オプションで追加のプロパティーを渡す必要があります。

プログラマティック

import org.infinispan.configuration.cache.*;

ConfigurationBuilder cacheCfg = ...

cacheCfg.indexing().index(Index.ALL)

.addProperty("property name", "propery value")

import org.infinispan.configuration.cache.*;

ConfigurationBuilder cacheCfg = ...

cacheCfg.indexing().index(Index.ALL)

.addProperty("property name", "propery value")14.2.2.1.2. Index names

index 要素内の各プロパティーの前には、org.infinispan.sample.Car というインデックス名が付けられます。directory_provider は local-heap です。

cacheCfg.indexing()

.index(Index.ALL)