Data Grid Server ガイド

Data Grid Server のデプロイメントのデプロイ、保護、および管理

概要

Red Hat Data Grid

Data Grid は、高性能の分散型インメモリーデータストアです。

- スキーマレスデータ構造

- さまざまなオブジェクトをキーと値のペアとして格納する柔軟性があります。

- グリッドベースのデータストレージ

- クラスター間でデータを分散および複製するように設計されています。

- エラスティックスケーリング

- サービスを中断することなく、ノードの数を動的に調整して要件を満たします。

- データの相互運用性

- さまざまなエンドポイントからグリッド内のデータを保存、取得、およびクエリーします。

Data Grid のドキュメント

Data Grid のドキュメントは、Red Hat カスタマーポータルで入手できます。

Data Grid のダウンロード

Red Hat カスタマーポータルで Data Grid Software Downloads にアクセスします。

Data Grid ソフトウェアにアクセスしてダウンロードするには、Red Hat アカウントが必要です。

多様性を受け入れるオープンソースの強化

Red Hat では、コード、ドキュメント、Web プロパティーにおける配慮に欠ける用語の置き換えに取り組んでいます。まずは、マスター (master)、スレーブ (slave)、ブラックリスト (blacklist)、ホワイトリスト (whitelist) の 4 つの用語の置き換えから始めます。この取り組みは膨大な作業を要するため、用語の置き換えは、今後の複数のリリースにわたって段階的に実施されます。詳細は、Red Hat CTO である Chris Wright のメッセージ をご覧ください。

第1章 Data Grid Server を使い始める

サーバーディストリビューションをインストールし、ユーザーを作成して、最初の Data Grid クラスターを起動します。

Ansible コレクション

オプションで Keycloak キャッシュおよびサイト間のレプリケーション設定が含まれる Ansible コレクションを使用して、Data Grid クラスターのインストールを自動化します。Ansible コレクションでは、インストール時に各サーバーインスタンスの静的設定に Data Grid キャッシュを挿入することもできます。

Data Grid の Ansible コレクション は、Red Hat Automation Hub から入手できます。

1.1. Data Grid Server の要件

Data Grid Server には Java 仮想マシンが必要です。サポートされるバージョンの詳細は、Data Grid Supported Configurations を参照してください。

1.2. Data Grid Server ディストリビューションのダウンロード

Data Grid Server ディストリビューションは、Java ライブラリー (JAR ファイル) および設定ファイルのアーカイブです。

手順

- Red Hat カスタマーポータルにアクセスします。

- ソフトウェアダウンロードセクション から Red Hat Data Grid 8.5 Server をダウンロードします。

以下のように、サーバーダウンロードアーカイブを引数として、

md5sumまたはsha256sumを実行します。sha256sum jboss-datagrid-${version}-server.zipsha256sum jboss-datagrid-${version}-server.zipCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

Data Grid Software Details ページで

MD5またはSHA-256チェックサムの値と比較します。

参照

- Data Grid Server README には、サーバーディストリビューションの内容が記載されています。

1.3. Data Grid Server のインストール

ホストシステムに Data Grid Server ディストリビューションをインストールします。

前提条件

- Data Grid Server ディストリビューションアーカイブをダウンロードします。

手順

- 適切なツールを使用して Data Grid Server のアーカイブをホストファイルシステムにデプロイメントします。

unzip redhat-datagrid-8.5.2-server.zip

unzip redhat-datagrid-8.5.2-server.zip

作成されたディレクトリーは $RHDG_HOME です。

1.4. Data Grid の JVM 設定

server.conf 設定ファイルを編集するか、JAVA_OPTS 環境変数を設定して、Data Grid の Java 仮想マシン (JVM) 設定を定義できます。

コンテナー内で Data Grid を実行している場合は、Xmx または Xms を設定しないでください。値はコンテナー設定からコンテナーサイズの 50% になるように自動的に計算されるためです。

設定ファイルの編集

server.conf 設定ファイルで必要な値を編集できます。たとえば、JVM に渡すオプションを設定するには、次の行を編集します。

JAVA_OPTS="-Xms64m -Xmx512m -XX:MetaspaceSize=64M -Djava.net.preferIPv4Stack=true" JAVA_OPTS="$JAVA_OPTS -Djava.awt.headless=true"

JAVA_OPTS="-Xms64m -Xmx512m -XX:MetaspaceSize=64M -Djava.net.preferIPv4Stack=true"

JAVA_OPTS="$JAVA_OPTS -Djava.awt.headless=true"既存のサンプル設定のコメントを解除することもできます。たとえば、リモートソケットデバッグ用に Java Platform Debugger Architecture (JPDA) 設定を構成するには、次のようにファイルを更新します。

# Sample JPDA settings for remote socket debugging JAVA_OPTS="$JAVA_OPTS -agentlib:jdwp=transport=dt_socket,address=8787,server=y,suspend=n"

# Sample JPDA settings for remote socket debugging

JAVA_OPTS="$JAVA_OPTS -agentlib:jdwp=transport=dt_socket,address=8787,server=y,suspend=n"

さらに、次のように JAVA_OPTS にさらに設定を追加することもできます。

JAVA_OPTS="$JAVA_OPTS <key_1>=<value_1>, ..., <key_N>=<value_N> "

JAVA_OPTS="$JAVA_OPTS <key_1>=<value_1>, ..., <key_N>=<value_N> "環境変数の設定

JAVA_OPTS 環境変数を設定して、server.conf 設定ファイルの設定を上書きできます。以下に例を示します。

Linux

export JAVA_OPTS="-Xmx1024M"

export JAVA_OPTS="-Xmx1024M"Microsoft Windows

set JAVA_OPTS="-Xmx1024M"

set JAVA_OPTS="-Xmx1024M"1.5. Data Grid Server の起動

サポートされる任意のホスト上の Java 仮想マシン (JVM) で、Data Grid Server インスタンスを実行します。

前提条件

- サーバーディストリビューションをダウンロードしてインストールします。

手順

-

$RHDG_HOMEでターミナルを開きます。 serverスクリプトで Data Grid Server インスタンスを起動します。- Linux

bin/server.sh

bin/server.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Microsoft Windows

bin\server.bat

bin\server.batCopy to Clipboard Copied! Toggle word wrap Toggle overflow

以下のメッセージがログに記録される場合は、Data Grid Server は正常に実行されています。

ISPN080004: Protocol SINGLE_PORT listening on 127.0.0.1:11222 ISPN080034: Server '...' listening on http://127.0.0.1:11222 ISPN080001: Data Grid Server <version> started in <mm>ms

ISPN080004: Protocol SINGLE_PORT listening on 127.0.0.1:11222

ISPN080034: Server '...' listening on http://127.0.0.1:11222

ISPN080001: Data Grid Server <version> started in <mm>ms検証

-

任意のブラウザーで

127.0.0.1:11222/console/を開きます。 - プロンプトで認証情報を入力し、Data Grid Console に進みます。

1.6. 起動時に Data Grid Server 設定を渡す

Data Grid Server の起動時にカスタム設定を指定します。

Data Grid Server は、--server-config 引数を使用して起動時にオーバーレイする複数の設定ファイルを解析できます。必要な数の設定オーバーレイファイルを任意の順序で使用できます。設定オーバーレイファイル:

-

有効なデータグリッド設定であり、ルート

server要素またはフィールドが含まれている必要があります。 - オーバーレイファイルの組み合わせが完全な設定になる限り、完全な設定である必要はありません。

Data Grid Server は、オーバーレイファイル間の競合する設定を検出しません。各オーバーレイファイルは、前述の設定で競合する設定を上書きします。

起動時にキャッシュ設定を Data Grid Server に渡した場合、これらのキャッシュはクラスター全体に動的に作成されません。キャッシュを各ノードに手動で伝播する必要があります。

さらに、起動時に Data Grid Server に渡すキャッシュ設定には、infinispan および cache-container 要素が含まれている必要があります。

前提条件

- サーバーディストリビューションをダウンロードしてインストールします。

-

カスタムサーバー設定を Data Grid Server インストールの

server/confディレクトリーに追加します。

手順

-

$RHDG_HOMEでターミナルを開きます。 以下のように、

--server-config=または-c引数を使用して 1 つ以上の設定ファイルを指定します。bin/server.sh -c infinispan.xml -c datasources.yaml -c security-realms.json

bin/server.sh -c infinispan.xml -c datasources.yaml -c security-realms.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.7. Data Grid ユーザーの作成

Hot Rod および REST エンドポイントを介して Data Grid Server のデプロイメントで認証するための認証情報を追加します。Data Grid Console へのアクセスやキャッシュ操作を行う前に、Data Grid のコマンドラインインタフェース (CLI) で最低 1 名のユーザーを作成する必要があります。

Data Grid は、ロールベースアクセス制御 (RBAC) を使用してセキュリティー認証を実施します。認証情報を初めて追加するときに admin ユーザーを作成して、Data Grid デプロイメントに対する完全な ADMIN 権限を取得します。

前提条件

- Data Grid Server をダウンロードし、インストールします。

手順

-

$RHDG_HOMEでターミナルを開きます。 user createコマンドでadminユーザーを作成します。bin/cli.sh user create admin -p changeme

bin/cli.sh user create admin -p changemeCopy to Clipboard Copied! Toggle word wrap Toggle overflow ヒントCLI セッションから

help userを実行し、コマンドの詳細を取得します。

検証

user.properties を開き、ユーザーが存在することを確認します。

cat server/conf/users.properties admin=scram-sha-1\:BYGcIAwvf6b...

cat server/conf/users.properties

admin=scram-sha-1\:BYGcIAwvf6b...CLI を使用してプロパティーレルムに認証情報を追加すると、接続しているサーバーインスタンスにのみユーザーが作成されます。プロパティーレルムの認証情報をクラスター内の各ノードに手動で同期する必要があります。

1.7.1. ユーザーへのロール付与

ユーザーにロールを割り当て、キャッシュ操作や Data Grid のリソースとのやり取りを行う権限を付与します。

同じロールを複数のユーザーに割り当て、それらの権限を一元管理する場合は、ユーザーではなくグループにロールを付与します。

前提条件

-

Data Grid に

ADMIN権限がある。 - Data Grid ユーザーを作成すること。

手順

- Data Grid への CLI 接続を作成します。

user roles grantコマンドでユーザーにロールを割り当てます。以下に例を示します。user roles grant --roles=deployer katie

user roles grant --roles=deployer katieCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

user roles ls コマンドでユーザーに付与したロールを一覧表示します。

user roles ls katie ["deployer"]

user roles ls katie

["deployer"]1.7.2. グループへのユーザーの追加

グループを使用すると、複数のユーザーのパーミッションを変更できます。グループにロールを割り当ててから、そのグループにユーザーを追加します。ユーザーは、グループロールからパーミッションを継承します。

グループは、Data Grid Server 設定のプロパティーレームの一部として使用します。各グループは、ユーザー名とパスワードも必要な特別なタイプのユーザーです。

前提条件

-

Data Grid に

ADMIN権限がある。 - Data Grid ユーザーを作成すること。

手順

- Data Grid への CLI 接続を作成します。

user createコマンドを使用してグループを作成します。-

--groups引数でグループ名を指定します。 グループのユーザー名とパスワードを設定します。

user create --groups=developers developers -p changeme

user create --groups=developers developers -p changemeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

グループをリスト表示します。

user ls --groups

user ls --groupsCopy to Clipboard Copied! Toggle word wrap Toggle overflow グループにロールを付与します。

user roles grant --roles=application developers

user roles grant --roles=application developersCopy to Clipboard Copied! Toggle word wrap Toggle overflow グループのロールを一覧表示します。

user roles ls developers

user roles ls developersCopy to Clipboard Copied! Toggle word wrap Toggle overflow 一度に 1 つずつグループにユーザーを追加します。

user groups john --groups=developers

user groups john --groups=developersCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

groups.properties を開き、グループが存在することを確認します。

cat server/conf/groups.properties

cat server/conf/groups.properties1.7.3. Data Grid のユーザーロールと権限

Data Grid には、キャッシュや Data Grid のリソースにアクセスするための権限をユーザーに提供するロールがいくつかあります。

| Role | パーミッション | 説明 |

|---|---|---|

|

| すべて | Cache Manager ライフサイクルの制御など、すべてのパーミッションを持つスーパーユーザー。 |

|

| ALL_READ、ALL_WRITE、LISTEN、EXEC、MONITOR、CREATE |

|

|

| ALL_READ、ALL_WRITE、LISTEN、EXEC、MONITOR |

|

|

| ALL_READ、MONITOR |

|

|

| MONITOR |

JMX および |

1.8. クラスタービューの確認

同じネットワーク上の Data Grid Server インスタンスは、自動的に相互に検出し、クラスターを形成します。

ローカルで実行されている Data Grid Server インスタンスを使用して、デフォルトの TCP スタックで MPING プロトコルを使用してクラスター検出を監視するには、この手順を実行します。カスタムネットワーク要件のクラスタートランスポートを調整する場合は、Data Grid クラスターの設定に関するドキュメントを参照してください。

この手順は、クラスター検出の原則を示すことを目的としており、実稼働環境を対象としていません。コマンドラインでポートオフセットを指定することは、実稼働用のクラスタートランスポートを設定するための信頼できる方法ではありません。

前提条件

Data Grid Server の 1 つのインスタンスを実行している。

手順

-

$RHDG_HOMEでターミナルを開きます。 root ディレクトリーを

server2にコピーします。cp -r server server2

cp -r server server2Copy to Clipboard Copied! Toggle word wrap Toggle overflow ポートオフセットと

server2ディレクトリーを指定します。bin/server.sh -o 100 -s server2

bin/server.sh -o 100 -s server2Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

127.0.0.1:11222/console/cluster-membership のコンソールでクラスターのメンバーシップを表示できます。

Data Grid は、ノードがクラスターに参加する際に、以下のメッセージも記録します。

1.9. Data Grid Server のシャットダウン

個別に実行中のサーバーを停止するか、クラスターを正常に停止します。

手順

- Data Grid への CLI 接続を作成します。

次のいずれかの方法で Data Grid Server をシャットダウンします。

shutdown clusterコマンドを使用して、クラスターのすべてのノードを停止します。以下に例を示します。shutdown cluster

shutdown clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドは、クラスターの各ノードの

dataフォルダーにクラスターの状態を保存します。キャッシュストアを使用する場合、shutdown clusterコマンドはキャッシュのすべてのデータも永続化します。shutdown serverコマンドおよびサーバーのホスト名を使用して、個々のサーバーインスタンスを停止します。以下に例を示します。shutdown server <my_server01>

shutdown server <my_server01>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

shutdown server コマンドは、リバランス操作が完了するまで待機しません。これにより、同時に複数のホスト名を指定すると、データが失われる可能性があります。

このコマンドの使用方法の詳細は、help shutdown を実行してください。

検証

Data Grid は、サーバーをシャットダウンしたときに以下のメッセージをログに記録します。

ISPN080002: Data Grid Server stopping ISPN000080: Disconnecting JGroups channel cluster ISPN000390: Persisted state, version=<$version> timestamp=YYYY-MM-DDTHH:MM:SS ISPN080003: Data Grid Server stopped

ISPN080002: Data Grid Server stopping

ISPN000080: Disconnecting JGroups channel cluster

ISPN000390: Persisted state, version=<$version> timestamp=YYYY-MM-DDTHH:MM:SS

ISPN080003: Data Grid Server stopped1.9.1. Data Grid クラスターのシャットダウンおよび再起動

ノードを適切にシャットダウンして再起動することで、データの損失を回避してクラスターの一貫性を確保します。

クラスターのシャットダウン

Data Grid では、クラスターの状態を保存し、キャッシュ内のすべてのデータを永続化する時には、shutdown cluster コマンドを使用してクラスター内のすべてのノードを停止することを推奨します。shutdown cluster コマンドは、ノードが 1 つ含まれるクラスターに対しても使用できます。

Data Grid クラスターをオンラインに戻すと、すべてのノードが再度参加するまで、クラスター内のすべてのノードおよびキャッシュが利用できなくなります。Data Grid は、不整合やデータ損失を防ぐために、クラスターに保存されているデータへのアクセスと、クラスター状態の変更を制限します。さらに、Data Grid はクラスターのリバランスを無効にし、起動時にローカルキャッシュストアがパージされないようにします。

クラスターの回復プロセス中に、コーディネーターノードは、新しいノードが参加するたびにメッセージをログに記録し、どのノードが使用可能でどのノードがまだ欠落しているかを示します。Data Grid クラスター内の他のノードには、参加時のビューが表示されます。Data Grid Console または REST API を使用して、キャッシュの可用性を監視できます。

ただし、すべてのノードを待機することが不要または望ましくない場合は、現在のトポロジーで使用可能なキャッシュを設定できます。この方法は、CLI (下記参照) または REST API を通じて可能です。

トポロジーを手動でインストールすると、データが失われる可能性があります。この操作は、初期トポロジーを再作成できない場合にのみ実行してください。

サーバーのシャットダウン

shutdown server コマンドを使用してノードを停止した後、オンラインに戻った最初のノードは、他のメンバーを待たずにすぐに使用できるようになります。残りのノードはすぐにクラスターに参加し、状態繊維がトリガーされますが、最初にローカル永続性が読み込まれるため、エントリーが失効する可能性があります。起動時にパージするように設定されたローカルキャッシュストアは、サーバーの起動時に空になります。purge=false としてマークされたローカルキャッシュストアは、サーバーの再起動後に使用可能になりますが、古いエントリーが含まれている可能性があります。

shutdown server コマンドを使用してクラスター化されたノードをシャットダウンする場合は、データ損失やキャッシュ内の古いエントリーに関連する問題が発生しないようにするために、各サーバーを逆の順序で再起動する必要があります。

たとえば、server1 をシャットダウンしてから、server2 をシャットダウンする場合は、最初に server2 を起動してから server1 を起動する必要があります。ただし、クラスター化されたノードを逆の順序で再起動しても、データ損失や古いエントリーを完全に防ぐことはできません。

1.10. Data Grid Server のインストールディレクトリー構造

Data Grid Server は、$RHDG_HOME の下のホストファイルシステムの以下のフォルダーを使用します。

$RHDG_HOME ディレクトリーの各フォルダーと、ファイルシステムのカスタマイズに使用できるシステムプロパティーに関する詳細は、Data Grid Server README を参照してください。

1.10.1. サーバー root ディレクトリー

bin および docs フォルダーのリソースの他に、対話する必要がある $RHDG_HOME 下の唯一のフォルダーは、デフォルトで server と名付けられたサーバー root ディレクトリーです。

同じ $RHDG_HOME ディレクトリーまたは別のディレクトリーに複数のノードを作成できますが、各 Data Grid Server インスタンスには、独自のサーバー root ディレクトリーが必要です。たとえば、5 つのノードのクラスターは、ファイルシステム上に以下のサーバー root ディレクトリーを持つことができます。

├── server ├── server1 ├── server2 ├── server3 └── server4

├── server

├── server1

├── server2

├── server3

└── server4各サーバーの root ディレクトリーには、以下のフォルダーが含まれている必要があります。

├── server │ ├── conf │ ├── data │ ├── lib │ └── log

├── server

│ ├── conf

│ ├── data

│ ├── lib

│ └── logserver/conf

Data Grid Server インスタンスの infinispan.xml 設定ファイルを保持します。

Data Grid は、設定を 2 つの層に分割します。

- 動的

-

データスケーラビリティーの変更可能なキャッシュ設定を作成します。

Data Grid Server は、実行時に作成したキャッシュを、ノード全体に分散されているクラスター状態とともに永続的に保存します。参加している各ノードは、変更が発生するたびに Data Grid Server がすべてのノード間で同期する完全なクラスター状態を受け取ります。 - 静的であること

-

クラスタートランスポート、セキュリティー、共有データソースなど、基盤となるサーバーのメカニズムに対して

infinispan.xmlに設定を追加します。

server/data

Data Grid Server がクラスターの状態を維持するために使用する内部ストレージを提供します。

server/data のコンテンツを直接削除または変更しないでください。

サーバーの実行中に caches.xml などのファイルを変更すると、破損が発生する可能性があります。コンテンツを削除すると、誤った状態になる可能性があります。つまり、シャットダウン後にクラスターを再起動できなくなります。

server/lib

カスタムフィルター、カスタムイベントリスナー、JDBC ドライバー、カスタム ServerTask 実装などの拡張 JAR ファイルが含まれます。

server/log

Data Grid Server のログファイルを保持します。

第2章 ネットワークインターフェイスおよびソケットバインディング

ネットワークインターフェイスを介して Data Grid Server を公開するには、IP アドレスにバインドします。その後、Data Grid Server がリモートクライアントアプリケーションからの要求を処理できるように、インターフェイスを使用するようにエンドポイントを設定することができます。

2.1. ネットワークインターフェイス

Data Grid Server は、単一の TCP/IP ポートへエンドポイントを多重化し、インバウンドクライアント要求のプロトコルを自動的に検出します。Data Grid Server が、クライアント要求をリッスンするようにネットワークインターフェイスにバインドする方法を設定できます。

インターネットプロトコル (IP) アドレス

XML

JSON

YAML

server:

interfaces:

- name: "public"

inetAddress:

value: "127.0.0.1"

server:

interfaces:

- name: "public"

inetAddress:

value: "127.0.0.1"ループバックアドレス

XML

JSON

YAML

server:

interfaces:

- name: "public"

loopback: ~

server:

interfaces:

- name: "public"

loopback: ~非ループバックアドレス

XML

JSON

YAML

server:

interfaces:

- name: "public"

nonLoopback: ~

server:

interfaces:

- name: "public"

nonLoopback: ~任意のアドレス

XML

JSON

YAML

server:

interfaces:

- name: "public"

anyAddress: ~

server:

interfaces:

- name: "public"

anyAddress: ~ローカルリンク

XML

JSON

YAML

server:

interfaces:

- name: "public"

linkLocal: ~

server:

interfaces:

- name: "public"

linkLocal: ~サイトローカル

XML

JSON

YAML

server:

interfaces:

- name: "public"

siteLocal: ~

server:

interfaces:

- name: "public"

siteLocal: ~2.1.1. 一致およびフォールバックストラテジー

Data Grid Server は、ホストシステム上のネットワークインターフェイスをすべて列挙し、値と一致するインターフェイス、ホスト、または IP アドレスにバインドできます。これには、柔軟性を高めるための正規表現を含むことができます。

ホストの一致

XML

JSON

YAML

server:

interfaces:

- name: "public"

matchHost:

value: "my_host_name"

server:

interfaces:

- name: "public"

matchHost:

value: "my_host_name"インターフェイスの一致

XML

JSON

YAML

server:

interfaces:

- name: "public"

matchInterface:

value: "eth0"

server:

interfaces:

- name: "public"

matchInterface:

value: "eth0"アドレスの一致

XML

JSON

YAML

server:

interfaces:

- name: "public"

matchAddress:

value: "127\\..*"

server:

interfaces:

- name: "public"

matchAddress:

value: "127\\..*"フォールバック

XML

JSON

YAML

2.2. ソケットバインディング

ソケットバインディングはエンドポイントコネクターをネットワークインターフェイスおよびポートにマッピングします。デフォルトでは、Data Grid Server には、REST および Hot Rod エンドポイントのポート 11222 で localhost インターフェイス 127.0.0.1 をリッスンするソケットバインディング設定が含まれています。Memcached エンドポイントを有効にすると、デフォルトのソケットバインディングは、ポート 11221 にバインドするように Data Grid Server を設定します。

デフォルトのソケットバインディング

| 設定要素または属性 | 説明 |

|---|---|

|

| Data Grid Server エンドポイントがクライアント接続をバインドおよびリッスンするすべてのネットワークインターフェイスおよびポートが含まれるルート要素。 |

|

| Data Grid Server がデフォルトでリッスンするネットワークインターフェイスを宣言します。 |

|

| Data Grid Server がソケットバインディングのポート宣言に適用するオフセットを指定します。 |

|

| ネットワークインターフェイスのポートにバインドするように Data Grid Server を設定します。 |

カスタムソケットバインディング宣言

以下の設定例では、"private" という名前の interface 宣言と、Data Grid Server をプライベート IP アドレスにバインドする socket-binding 宣言を追加します。

XML

JSON

YAML

2.3. Data Grid Server のバインドアドレスの変更

Data Grid Server は、Hot Rod エンドポイントおよび REST エンドポイントでインバウンドクライアント接続をリッスンするネットワーク IP アドレスにバインドします。IP アドレスを直接 Data Grid Server 設定で指定するか、サーバーインスタンスの起動時に指定できます。

前提条件

- 1 つ以上の Data Grid Server がインストールされている。

手順

以下のいずれかの方法で、Data Grid Server がバインドする IP アドレスを指定します。

Data Grid Server 設定を開き、

inet-address要素の値を設定します。以下に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow -bオプションまたはinfinispan.bind.addressシステムプロパティーを使用します。Linux

bin/server.sh -b 192.0.2.0

bin/server.sh -b 192.0.2.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow Windows

bin\server.bat -b 192.0.2.0

bin\server.bat -b 192.0.2.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.1. すべてのアドレスのリッスン

Data Grid Server 設定のバインドアドレスとして 0.0.0.0 メタアドレスまたは INADDR_ANY を指定すると、利用可能なすべてのネットワークインターフェイスで着信クライアント接続をリッスンします。

クライアントのインテリジェンス

すべてのアドレスでリッスンするように Data Grid を設定すると、クラスタートポロジーで Hot Rod クライアントを提供する方法に影響します。Data Grid Server がバインドするインターフェイスが複数ある場合は、各インターフェイスに対して IP アドレスのリストを送信します。

たとえば、各サーバーノードがバインドするクラスターは以下のようになります。

-

10.0.0.0/8サブネット -

192.168.0.0/16サブネット -

127.0.0.1ループバック

Hot Rod クライアントは、クライアントが接続するインターフェイスに属するサーバーノードの IP アドレスを受信します。クライアントが 192.168.0.0 に接続する場合、たとえば、10.0.0.0 でリッスンするノードには、クラスタートポロジーの詳細を受け取りません。

ネットマスクの上書き

Kubernetes およびその他の環境は、IP アドレスの領域をサブネットに分割し、その異なるサブネットを単一のネットワークとして使用します。たとえば、10.129.2.100/23 および 10.129.4.100/23 は異なるサブネットにありますが、10.0.0.0/8 ネットワークに属します。

このため、Data Grid Server は、ホストシステムが提供するネットマスクを、プライベートネットワークと予約ネットワークの IANA 規約に従ったネットマスクで上書きします。

-

IPv4:

10.0.0.0/8、100.64.0.0/10、192.168.0.0/16`、172.16.0.0/12、169.254.0.0/16、および240.0.0.0/4 -

IPv6:

fc00::/7およびfe80::/10

IPv4 については RFC 1112、RFC 1918、RFC 3927、RFC 6598、IPv6 については RFC 4193、RFC 3513 を参照してください。

必要に応じて、ホストシステムが Data Grid Server 設定の network-prefix-override 属性を持つインターフェイスに提供するネットマスクを使用するように Hot Rod コネクターを設定できます。

2.4. Data Grid Server ポートおよびプロトコル

Data Grid Server は、異なるプロトコルでのクライアントアクセスを許可するネットワークエンドポイントを提供します。

| ポート | Protocol | 説明 |

|---|---|---|

|

| TCP | Hot Rod および REST |

|

| TCP | Memcached(デフォルトでは無効) |

単一ポート

Data Grid Server は、1 つの TCP ポート 11222 で複数のプロトコルを公開します。1 つのポートで複数のプロトコルを処理すると、設定が簡素化され、Data Grid クラスターをデプロイする際の管理の複雑さが軽減されます。また、1 つのポートを使用すると、ネットワーク上の攻撃対象領域が最小限に抑えられるため、セキュリティーも強化されます。

Data Grid Server は、クライアントからの HTTP/1.1、HTTP/2、および Hot Rod プロトコル要求を、さまざまな方法で単一のポートを介して処理します。

HTTP/1.1 アップグレードヘッダー

クライアントリクエストには、HTTP/1.1 upgrade ヘッダーフィールドを追加して、Data Grid Server と HTTP/1.1 の接続を開始できます。続いて、クライアントアプリケーションは Upgrade: protocol ヘッダーフィールドを送信できます。ここで、protocol はサーバーエンドポイントになります。

Application-Layer Protocol Negotiation (ALPN)/Transport Layer Security (TLS)

クライアント要求には、TLS 接続を介してプロトコルをネゴシエートするための Data Grid Server エンドポイントの Server Name Indication (SNI) マッピングが含まれます。

Hot Rod の自動検出

Hot Rod ヘッダーを含むクライアントリクエストは、自動的に Hot Rod エンドポイントにルーティングされます。

2.4.1. Data Grid トラフィック用のネットワークファイアウォールの設定

ファイアウォールルールを調整して、Data Grid Server とクライアントアプリケーションの間のトラフィックを許可します。

手順

Red Hat Enterprise Linux (RHEL) ワークステーションでは、たとえば、以下のように firewalld を使用してポート 11222 へのトラフィックを許可できます。

firewall-cmd --add-port=11222/tcp --permanent success firewall-cmd --list-ports | grep 11222 11222/tcp

# firewall-cmd --add-port=11222/tcp --permanent

success

# firewall-cmd --list-ports | grep 11222

11222/tcpネットワーク全体に適用されるファイアウォールルールを設定するには、nftables ユーティリティーを使用できます。

2.5. ポートオフセットの指定

同じホストで複数の Data Grid Server インスタンスのポートオフセットを設定します。デフォルトのポートオフセットは 0 です。

手順

Data Grid CLI または infinispan.socket.binding.port-offset システムプロパティーで -o スイッチを使用して、ポートオフセットを設定します。

たとえば、以下のようにオフセットが 100 のサーバーインスタンスを起動します。デフォルトの設定では、これにより、Data Grid Server がポート 11322 でリッスンします。

- Linux

bin/server.sh -o 100

bin/server.sh -o 100- Windows

bin\server.bat -o 100

bin\server.bat -o 100第3章 Data Grid Server エンドポイント

Data Grid Server のエンドポイントは、Hot Rod および REST プロトコルを介して、キャッシュマネージャーへのクライアントアクセスを提供します。

3.1. Data Grid Server エンドポイント

3.1.1. Hot Rod

Hot Rod は、テキストベースのプロトコルと比較して、データへのアクセス時間を短縮し、パフォーマンスを向上するために設計されたバイナリー TCP クライアントサーバープロトコルです。

Data Grid は、Java、C++、C#、Node.js、およびその他のプログラミング言語で Hot Rod クライアントライブラリーを提供します。

トポロジーキャッシュ

Data Grid はトポロジーキャッシュを使用して、クライアントにクラスタービューを提供します。トポロジーキャッシュには、内部 JGroups トランスポートアドレスを公開された Hot Rod エンドポイントにマッピングするエントリーが含まれます。

クライアントが要求を送信すると、Data Grid サーバーは、要求ヘッダーのトポロジー ID をキャッシュからのトポロジー ID と比較します。クライアントに古いトポロジー ID がある場合は、Data Grid サーバーは新しいトポロジービューを送信します。

クラスタートポロジービューを使用すると、Hot Rod クライアントは、ノードがいつ参加および離脱するかを即座に検出できるため、動的な負荷分散とフェイルオーバーが可能になります。

分散キャッシュモードでは、一貫性のあるハッシュアルゴリズムにより、Hot Rod クライアント要求をプライマリー所有者に直接ルーティングすることもできます。

3.1.2. REST

Data Grid は、HTTP クライアントがデータにアクセスし、クラスターを監視および保守し、管理操作を実行できるようにする RESTful インターフェイスを公開します。

標準の HTTP ロードバランサーを使用して、クライアントに負荷分散およびフェイルオーバー機能を提供できます。ただし、HTTP ロードバランサーは静的クラスタービューを維持し、クラスタートポロジーの変更が発生したときに手動で更新する必要があります。

3.1.3. RESP

Data Grid は、RESP3 プロトコルの実装を提供します。

RESP コネクターは、Redis コマンドのサブセットをサポートします。

3.1.4. Memcached

Data Grid は、リモートクライアントアクセス用の Memcached テキストおよびバイナリープロトコルの実装を提供します。

Data Grid Memcached エンドポイントは、レプリケートおよび分散キャッシュモードを使用したクラスタリングをサポートします。

Cache::Memcached Perl クライアントなどの一部の Memcached クライアント実装は、クラスタートポロジーの変更時に手動更新を必要とする Data Grid サーバーアドレスの静的リストで負荷分散およびフェイルオーバー検出機能を提供できます。

3.1.5. エンドポイントプロトコルの比較

| Hot Rod | HTTP / REST | Memcached | RESP | |

|---|---|---|---|---|

| トポロジー対応 | Y | N | N | N |

| ハッシュ対応 | Y | N | N | N |

| 暗号化 | Y | Y | Y | Y |

| 認証 | Y | Y | Y | Y |

| 条件付き操作 | Y | Y | Y | N |

| バルク操作 | Y | N | Y | Y |

| トランザクション | Y | N | N | N |

| リスナー | Y | N | N | Y |

| クエリー | Y | Y | N | N |

| Execution | Y | N | N | N |

| クロスサイトフェイルオーバー | Y | N | N | N |

3.1.6. Hot Rod クライアントの Data Grid Server との互換性

Data Grid Server を使用すると、異なるバージョンの Hot Rod クライアントを接続することができます。たとえば、Data Grid クラスターへの移行またはアップグレードの際に、Hot Rod クライアントのバージョンが Data Grid Server よりも低い Data Grid バージョンになることがあります。

Data Grid は、最新の機能およびセキュリティー機能強化の恩恵を受けるために、最新の Hot Rod クライアントバージョンを使用することを推奨しています。

Data Grid 8 以降

Hot Rod プロトコルバージョン 3.x は、Data Grid Server のクライアントに対して、可能な限り高いバージョンを自動的にネゴシエートします。

Data Grid 7.3 以前

Data Grid Server バージョンよりも高い Hot Rod プロトコルバージョンを使用するクライアントは、infinispan.client.hotrod.protocol_version プロパティーを設定する必要があります。

3.2. Data Grid Server エンドポイントの設定

さまざまなプロトコルエンドポイントがソケットにバインドし、セキュリティーレルム設定を使用する方法を制御します。複数のエンドポイントを設定し、管理機能を無効にすることもできます。

各一意のエンドポイント設定には、Hot Rod コネクターと REST コネクターの両方が含まれている必要があります。Data Grid Server は、endpoint 設定に hotrod-connector 要素と rest-connector 要素またはフィールドを暗黙的に含みます。これらの要素をカスタム設定に追加し、エンドポイントの認証メカニズムを指定する必要があります。

前提条件

- ソケットバインディングとセキュリティーレルムを Data Grid Server 設定に追加します。

手順

- Data Grid Server 設定を開いて編集します。

-

endpoints要素で複数のendpoint設定をラップします。 -

エンドポイントが

socket-binding属性で使用するソケットバインディングを指定します。 -

エンドポイントが

security-realm属性で使用するセキュリティーレルムを指定します。 必要に応じて、

admin="false"属性を使用して管理者アクセスを無効にします。この設定では、ユーザーはエンドポイントから Data Grid Console またはコマンドラインインターフェイス (CLI) にアクセスできません。

- 変更を設定に保存します。

複数のエンドポイント設定

以下の Data Grid Server 設定は、専用のセキュリティーレルムを持つ個別のソケットバインディングにエンドポイントを作成します。

XML

JSON

YAML

3.3. エンドポイントコネクター

コネクターは、ソケットバインディングおよびセキュリティーレルムを使用するように Hot Rod および REST エンドポイントを設定します。

デフォルトのエンドポイント設定

<endpoints socket-binding="default" security-realm="default"/>

<endpoints socket-binding="default" security-realm="default"/>| 設定要素または属性 | 説明 |

|---|---|

|

| エンドポイントコネクター設定をラップします。 |

|

| ソケットバインディングおよびセキュリティーレルムを使用するように Hot Rod および REST コネクターを設定する Data Grid Server エンドポイントを宣言します。 |

|

|

エンドポイント設定に Hot Rod |

|

|

|

|

|

|

|

|

|

3.4. エンドポイント IP アドレスのフィルタールール

Data Grid Server エンドポイントは、クライアントが IP アドレスに基づいて接続できるかどうかを制御するフィルタールールを使用できます。Data Grid Server は、クライアント IP アドレスの一致を見つけるまで、フィルタリングルールを順番に適用します。

CIDR ブロックは、IP アドレスとそれに関連するネットワークマスクのコンパクトな表現です。CIDR 表記は、IP アドレス、スラッシュ ('/') 文字、および 10 進数を指定します。10 進数は、ネットワークマスクの先頭の 1 ビットのカウントです。この数は、ネットワーク接頭辞の幅 (ビット単位) として考えることもできます。CIDR 表記の IP アドレスは、常に IPv4 または IPv6 の標準仕様によって表されます。

アドレスは、ホスト ID(例: 10.0.0.1/8 など) を含む特定のインターフェイスアドレスを指定できます。もしくは、10.0.0.0/8 または 10/8 のように 0 のホスト識別子を使用して、ネットワークインターフェイス全体の開始アドレスを指定できます。

以下に例を示します。

-

192.168.100.14/24は、IPv4 アドレス192.168.100.14とその関連付けられたネットワーク接頭辞192.168.100.0を表します。または、先行 1 ビットを 24 個持つサブネットマスク255.255.255.0となります。 -

IPv4 ブロック

192.168.100.0/22は、192.168.100.0から192.168.103.255までの 1024 IPv4 アドレスを表します。 -

IPv6 ブロック

2001:db8::/48は2001:db8:0:0:0:0:0:0から2001:db8:0:ffff:ffff:ffff:ffff:ffffまでの IPv6 アドレスのブロックを表します。 -

::1/128は IPv6 ループバックアドレスを表します。接頭辞長は 128 で、アドレスのビット数になります。

IP アドレスフィルターの設定

次の設定では、Data Grid Server は 192.168.0.0/16 および 10.0.0.0/8CIDR ブロックのアドレスからの接続のみを受け入れます。Data Grid Server は、他のすべての接続を拒否します。

XML

JSON

YAML

3.5. IP アドレスをフィルターするためのルールの検証および変更

クライアントアドレスに基づいて、接続を許可または拒否するように、Data Grid Server エンドポイントで IP アドレスフィルタールールを設定します。

前提条件

- Data Grid コマンドラインインターフェイス (CLI) のインストール

手順

- Data Grid Server への CLI 接続を作成します。

必要に応じて、IP フィルタールール

server connector ipfilterコマンドを検査して変更します。クラスター全体のコネクターでアクティブな IP フィルタリングルールの一覧を表示します。

server connector ipfilter ls endpoint-default

server connector ipfilter ls endpoint-defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow クラスター全体で IP フィルタリングルールを設定します。

注記このコマンドは、既存のルールを置き換えます。

server connector ipfilter set endpoint-default --rules=ACCEPT/192.168.0.0/16,REJECT/10.0.0.0/8`

server connector ipfilter set endpoint-default --rules=ACCEPT/192.168.0.0/16,REJECT/10.0.0.0/8`Copy to Clipboard Copied! Toggle word wrap Toggle overflow クラスター全体のコネクターですべての IP フィルタリングルールを削除します。

server connector ipfilter clear endpoint-default

server connector ipfilter clear endpoint-defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第4章 エンドポイント認証メカニズム

Data Grid Server は、Hot Rod および REST エンドポイントにカスタム SASL および HTTP 認証メカニズムを使用できます。

4.1. Data Grid Server の認証

認証は、エンドポイントへのユーザーアクセスと、Data Grid Console およびコマンドラインインターフェイス (CLI) を制限します。

Data Grid Server には、ユーザー認証を強制する "デフォルト" のセキュリティーレルムが含まれます。デフォルトの認証は、server/conf/users.properties ファイルに保存されているユーザー認証情報とともにプロパティーレルムを使用します。Data Grid Server はデフォルトでセキュリティー認証も有効にするため、server/conf/groups.properties ファイルに保存されているパーミッションを持つユーザーを割り当てる必要があります。

コマンドラインインターフェイス (CLI) で user create コマンドを使用して、ユーザーを追加し、パーミッションを割り当てます。サンプルおよび詳細情報は、user create --help を実行します。

4.2. Data Grid Server の認証メカニズムの設定

特定の認証メカニズムを使用するように Hot Rod および REST エンドポイントを明示的に設定することができます。認証メカニズムの設定は、セキュリティーレルムのデフォルトメカニズムを明示的に上書きする必要がある場合にのみ必要です。

設定の各 endpoint セクションには、hotrod-connector および rest-connector 要素またはフィールドが含まれている必要があります。たとえば、hotrod-connector を明示的に宣言する場合は、認証メカニズムを設定しない場合でも rest-connector も宣言する必要があります。

前提条件

- 必要に応じて、Data Grid Server 設定にセキュリティーレルムを追加します。

手順

- Data Grid Server 設定を開いて編集します。

-

endpoint要素またはフィールドを追加し、security-realm属性で使用するセキュリティーレルムを指定します。 hotrod-connector要素またはフィールドを追加して、Hot Rod エンドポイントを設定します。-

authentication要素またはフィールドを追加します。 -

sasl mechanism属性で使用する Hot Rod エンドポイントの SASL 認証メカニズムを指定します。 -

該当する場合は、

qop属性で SASL 品質の保護設定を指定します。 -

必要に応じて

server-name属性を使用して Data Grid Server アイデンティティーを指定します。

-

rest-connector要素またはフィールドを追加して REST エンドポイントを設定します。-

authentication要素またはフィールドを追加します。 -

mechanism属性で使用する REST エンドポイントの HTTP 認証メカニズムを指定します。

-

- 変更を設定に保存します。

認証メカニズムの設定

以下の設定では、Hot Rod エンドポイントが認証に使用する SASL メカニズムを指定します。

XML

JSON

YAML

4.2.1. 認証の無効化

ローカル開発環境または分離されたネットワークでは、認証されていないクライアント要求を許可するように Data Grid を設定できます。ユーザー認証を無効にする場合は、Data Grid セキュリティー設定で承認も無効にする必要があります。

手順

- Data Grid Server 設定を開いて編集します。

-

endpoints要素またはフィールドからsecurity-realm属性を削除します。 -

cache-containerおよび各キャッシュ設定のsecurity設定から、authorization要素をすべて削除します。 - 変更を設定に保存します。

XML

<server xmlns="urn:infinispan:server:15.0"> <endpoints socket-binding="default"/> </server>

<server xmlns="urn:infinispan:server:15.0">

<endpoints socket-binding="default"/>

</server>JSON

YAML

server:

endpoints:

endpoint:

socketBinding: "default"

server:

endpoints:

endpoint:

socketBinding: "default"4.3. Data Grid Server の認証メカニズム

Data Grid Server は、セキュリティーレルム設定に一致する認証メカニズムでエンドポイントを自動的に設定します。たとえば、Kerberos セキュリティーレルムを追加すると、Data Grid Server は Hot Rod エンドポイントの GSSAPI および GS2-KRB5 認証メカニズムを有効にします。

現在、Lightweight Directory Access Protocol (LDAP) プロトコルと DIGEST または SCRAM 認証メカニズムは、特定のハッシュ化されたパスワードにアクセスする必要があるため、使用できません。

ホットローテーションエンドポイント

Data Grid Server は、設定に対応するセキュリティーレルムが含まれている場合に Hot Rod エンドポイントの以下の SASL 認証メカニズムを有効にします。

| セキュリティーレルム | SASL 認証メカニズム |

|---|---|

| プロパティーレルムおよび LDAP レルム |

|

| トークンレルム |

|

| 信頼レルム |

|

| Kerberos ID |

|

| SSL/TLS ID |

|

REST エンドポイント

Data Grid Server は、設定に対応するセキュリティーレルムが含まれている場合に REST エンドポイントの以下の HTTP 認証メカニズムを有効にします。

| セキュリティーレルム | HTTP 認証メカニズム |

|---|---|

| プロパティーレルムおよび LDAP レルム |

|

| トークンレルム |

|

| 信頼レルム |

|

| Kerberos ID |

|

| SSL/TLS ID |

|

Memcached エンドポイント

Data Grid Server は、設定に対応するセキュリティーレルムが含まれている場合、Memcached バイナリープロトコルエンドポイントに対して次の SASL 認証メカニズムを有効にします。

| セキュリティーレルム | SASL 認証メカニズム |

|---|---|

| プロパティーレルムおよび LDAP レルム |

|

| トークンレルム |

|

| 信頼レルム |

|

| Kerberos ID |

|

| SSL/TLS ID |

|

Data Grid Server は、パスワードベースの認証をサポートするセキュリティーレルムでのみ、Memcached テキストプロトコルエンドポイントでの認証を有効にします。

| セキュリティーレルム | Memcached テキスト認証 |

|---|---|

| プロパティーレルムおよび LDAP レルム | はい |

| トークンレルム | いいえ |

| 信頼レルム | いいえ |

| Kerberos ID | いいえ |

| SSL/TLS ID | いいえ |

RESP エンドポイント

Data Grid Server は、パスワードベースの認証をサポートするセキュリティーレルムでのみ、RESP エンドポイントでの認証を有効にします。

| セキュリティーレルム | RESP 認証 |

|---|---|

| プロパティーレルムおよび LDAP レルム | はい |

| トークンレルム | いいえ |

| 信頼レルム | いいえ |

| Kerberos ID | いいえ |

| SSL/TLS ID | いいえ |

4.3.1. SASL 認証メカニズム

Data Grid Server は、Hot Rod および Memcached バイナリープロトコルエンドポイントを使用して、次の SASL 認証メカニズムをサポートします。

| 認証メカニズム | 説明 | セキュリティーレルムタイプ | 関連する詳細 |

|---|---|---|---|

|

|

プレーンテキスト形式の認証情報を使用します。 | プロパティーレルムおよび LDAP レルム |

|

|

|

ハッシュアルゴリズムとナンス値を使用します。ホットロッドコネクターは、強度の順に、 | プロパティーレルムおよび LDAP レルム |

|

|

|

ハッシュアルゴリズムとナンス値に加えて ソルト 値を使用します。ホットロッドコネクターは、 | プロパティーレルムおよび LDAP レルム |

|

|

|

Kerberos チケットを使用し、Kerberos ドメインコントローラーが必要です。対応する | Kerberos レルム |

|

|

|

Kerberos チケットを使用し、Kerberos ドメインコントローラーが必要です。対応する | Kerberos レルム |

|

|

| クライアント証明書を使用します。 | トラストストアレルム |

|

|

|

OAuth トークンを使用し、 | トークンレルム |

|

4.3.2. SASL Quality of Protection (QoP)

SASL メカニズムが整合性およびプライバシー保護 (QoP) 設定をサポートする場合は、qop 属性を使用して Hot Rod および Memcached エンドポイント設定に追加できます。

| QoP 設定 | 説明 |

|---|---|

|

| 認証のみ。 |

|

| 整合性保護による認証。 |

|

| 整合性とプライバシー保護による認証。 |

4.3.3. SASL ポリシー

SASL ポリシーは、Hot Rod および Memcached 認証メカニズムをきめ細かく制御します。

Data Grid のキャッシュ承認では、ロールおよびパーミッションに基づいてキャッシュへのアクセスを制限します。キャッシュ認証を設定し、<no-anonymous value=false /> を設定して匿名ログインを許可し、アクセスロジックをキャッシュ承認に委譲します。

| ポリシー | 説明 | デフォルト値 |

|---|---|---|

|

| セッション間の forward secrecy をサポートする SASL メカニズムのみを使用します。これは、1 つのセッションに分割しても、将来のセッションに分割するための情報が自動的に提供されないことを意味します。 | false |

|

| クライアント認証情報が必要な SASL メカニズムのみを使用してください。 | false |

|

| 単純な受動的攻撃の影響を受けやすい SASL メカニズムは使用しないでください。 | false |

|

| アクティブな非辞書攻撃の影響を受けやすい SASL メカニズムは使用しないでください。 | false |

|

| 受動的な辞書攻撃の影響を受けやすい SASL メカニズムは使用しないでください。 | false |

|

| 匿名ログインを許可する SASL メカニズムは使用しないでください。 | true |

SASL ポリシーの設定

以下の設定では、Hot Rod エンドポイントは、すべての SASL ポリシーに準拠する唯一のメカニズムであるため、認証に GSSAPI メカニズムを使用します。

XML

JSON

YAML

4.3.4. HTTP 認証メカニズム

Data Grid Server は、REST エンドポイントに以下の HTTP 認証メカニズムをサポートします。

| 認証メカニズム | 説明 | セキュリティーレルムタイプ | 関連する詳細 |

|---|---|---|---|

|

|

プレーンテキスト形式の認証情報を使用します。暗号化された接続でのみ | プロパティーレルムおよび LDAP レルム |

HTTP |

|

|

ハッシュアルゴリズムとナンス値を使用します。REST コネクターは、 | プロパティーレルムおよび LDAP レルム |

|

|

|

Kerberos チケットを使用し、Kerberos ドメインコントローラーが必要です。対応する | Kerberos レルム |

|

|

|

OAuth トークンを使用し、 | トークンレルム |

|

|

| クライアント証明書を使用します。 | トラストストアレルム |

|

第5章 セキュリティーレルム

セキュリティーレルムは、ユーザー ID にアクセスおよび検証する環境内のネットワークプロトコルおよびインフラストラクチャーと Data Grid Server デプロイメントを統合します。

5.1. セキュリティーレルムの作成

セキュリティーレルムを Data Grid Server 設定に追加し、デプロイメントへのアクセスを制御します。設定に 1 つ以上のセキュリティーレルムを追加できます。

設定にセキュリティーレルムを追加すると、Data Grid Server は Hot Rod および REST エンドポイントの一致する認証メカニズムを自動的に有効にします。

前提条件

- 必要に応じて、ソケットバインディングを Data Grid Server 設定に追加します。

キーストアを作成するか、PEM ファイルがあり、TLS/SSL 暗号化でセキュリティーレルムを設定します。

Data Grid Server は起動時にキーストアを生成することもできます。

-

セキュリティーレルム設定に依存するリソースまたはサービスをプロビジョニングします。

たとえば、トークンレルムを追加する場合は、OAuth サービスをプロビジョニングする必要があります。

この手順では、複数のプロパティーレルムを設定する方法を説明します。開始する前に、ユーザーを追加し、コマンドラインインターフェイス (CLI) でパーミッションを割り当てるプロパティーファイルを作成する必要があります。user create コマンドを使用します。

サンプルおよび詳細情報は、user create --help を実行します。

CLI を使用してプロパティーレルムに認証情報を追加すると、接続しているサーバーインスタンスにのみユーザーが作成されます。プロパティーレルムの認証情報をクラスター内の各ノードに手動で同期する必要があります。

手順

- Data Grid Server 設定を開いて編集します。

-

複数のセキュリティーレルムの作成を含めるには、

security設定のsecurity-realms要素を使用します。 security-realm要素でセキュリティーレルムを追加し、name属性の一意の名前を付けます。この例に従うには、

application-realmという名前のセキュリティーレルムと、management-realmという名前の 1 つのセキュリティーレルムを作成します。-

Data Grid Server の TLS/SSL 識別に

server-identities要素を指定して、必要に応じてキーストアを設定します。 以下の要素またはフィールド 1 つを追加して、セキュリティーレルムのタイプを指定します。

-

properties-realm -

ldap-realm -

token-realm -

truststore-realm

-

必要に応じて、設定するセキュリティーレルムタイプのプロパティーを指定します。

例に従うには、

user-propertiesおよびgroup-properties要素またはフィールドのpath属性を使用して、CLI で作成した*.propertiesファイルを指定します。-

複数の異なるタイプのセキュリティーレルムを設定に追加する場合は、

distributed-realm要素またはフィールドを含めて、Data Grid Server がレルムを相互に組み合わせて使用できるようにします。 -

security-realm属性でセキュリティーレルムを使用するように Data Grid Server エンドポイントを設定します。 - 変更を設定に保存します。

複数のプロパティーレルム

XML

JSON

YAML

5.2. Kerberos ID の設定

Data Grid Server 設定のセキュリティーレルムに Kerberos ID を追加して、Kerberos パスワードから派生するサービスプリンシパル名と暗号化されたキーが含まれる keytab ファイルを使用します。

前提条件

- Kerberos サービスアカウントプリンシパルがある。

キータブ ファイルには、ユーザーとサービスのアカウントプリンシパルの両方を含めることができます。しかし、Data Grid Server はサービスアカウントプリンシパルのみを使用します。これは、クライアントに ID を提供し、クライアントが Kerberos サーバーで認証できることを意味します。

ほとんどの場合、Hot Rod および REST エンドポイントに固有のプリンシパルを作成します。たとえば、"INFINISPAN.ORG" ドメインに "datagrid" サーバーがある場合は、以下のサービスプリンシパルを作成する必要があります。

-

hotrod/datagrid@INFINISPAN.ORGは Hot Rod サービスを特定します。 -

HTTP/datagrid@INFINISPAN.ORGは REST サービスを識別します。

手順

Hot Rod および REST サービスのキータブファイルを作成します。

- Linux

ktutil ktutil: addent -password -p datagrid@INFINISPAN.ORG -k 1 -e aes256-cts Password for datagrid@INFINISPAN.ORG: [enter your password] ktutil: wkt http.keytab ktutil: quit

ktutil ktutil: addent -password -p datagrid@INFINISPAN.ORG -k 1 -e aes256-cts Password for datagrid@INFINISPAN.ORG: [enter your password] ktutil: wkt http.keytab ktutil: quitCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Microsoft Windows

ktpass -princ HTTP/datagrid@INFINISPAN.ORG -pass * -mapuser INFINISPAN\USER_NAME ktab -k http.keytab -a HTTP/datagrid@INFINISPAN.ORG

ktpass -princ HTTP/datagrid@INFINISPAN.ORG -pass * -mapuser INFINISPAN\USER_NAME ktab -k http.keytab -a HTTP/datagrid@INFINISPAN.ORGCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

keytab ファイルを Data Grid Server インストールの

server/confディレクトリーにコピーします。 - Data Grid Server 設定を開いて編集します。

-

server-identities定義を Data Grid サーバーのセキュリティーレルムに追加します。 - Hot Rod および REST コネクターにサービスプリンシパルを提供するキータブファイルの場所を指定します。

- Kerberos サービスプリンシパルに名前を付けます。

- 変更を設定に保存します。

Kerberos ID の設定

XML

JSON

YAML

5.3. プロパティーレルム

プロパティーレルムはプロパティーファイルを使用して、ユーザーおよびグループを定義します。

-

users.propertiesには Data Grid ユーザーの認証情報が含まれます。パスワードは、DIGEST-MD5およびDIGEST認証メカニズムを使用して事前署名できます。 -

groups.propertiesは、ユーザーをロールおよびパーミッションに関連付けます。

users.properties

myuser=a_password user2=another_password

myuser=a_password

user2=another_passwordgroups.properties

myuser=supervisor,reader,writer user2=supervisor

myuser=supervisor,reader,writer

user2=supervisorプロパティーレルム設定

XML

JSON

YAML

5.3.1. プロパティーレルムファイル構造

ユーザープロパティーファイルは次のように構造化されています。

users.properties 構造

#$REALM_NAME=default$ #$ALGORITHM=encrypted$ #Wed Jul 31 08:32:08 CEST 2024 admin=algorithm-1\:hash-1;algorithm-2\:hash-2;...

#$REALM_NAME=default$

#$ALGORITHM=encrypted$

#Wed Jul 31 08:32:08 CEST 2024

admin=algorithm-1\:hash-1;algorithm-2\:hash-2;...

最初の 3 行は、レルムの名前 ($REALM_NAME)、パスワードが clear 形式または encrypted 形式で保存されるかどうか ($ALGORITHM)、および最終更新のタイムスタンプを定義する特別なコメントです。

ユーザー認証情報は従来のキー/値形式で保存されます。キーはユーザー名に対応し、値はパスワードに対応します。暗号化されたパスワードは、セミコロンで区切られたアルゴリズム/ハッシュのペアとして表され、ハッシュは Base64 でエンコードされます。

認証情報はレルム名を使用して暗号化されます。レルムの名前を変更するには、すべてのパスワードを再暗号化する必要があります。Data Grid CLI を使用して、ファイルに正しいセキュリティーレルム名を入力します。

5.4. LDAP レルム

LDAP レルムは、OpenLDAP、Red Hat Directory Server、Apache Directory Server、Microsoft Active Directory などの LDAP サーバーに接続して、ユーザーを認証し、メンバーシップ情報を取得します。

LDAP サーバーは、サーバーのタイプとデプロイメントに応じて、異なるエントリーレイアウトを持つことができます。考えられるすべての設定の例を提供することは、このドキュメントでは扱っていません。

5.4.1. LDAP 接続プロパティー

LDAP レルム設定で LDAP 接続プロパティーを指定します。

次のプロパティーが必要です。

| url |

LDAP サーバーの URL を指定します。TLS を使用したセキュアな接続のために、URL は |

| principal | LDAP サーバー内の有効なユーザーの識別名 (DN) を指定します。DN は、LDAP ディレクトリー構造内でユーザーを一意に識別します。 |

| credential | 前述のプリンシパルに関連するパスワードに対応します。 |

LDAP 接続のプリンシパルには、LDAP クエリーを実行し、特定の属性にアクセスするために必要な権限が必要です。

connection-pooling を有効にすると、LDAP サーバーに対する認証のパフォーマンスが大幅に向上します。接続プーリングメカニズムは JDK によって提供されます。詳細は、接続プーリングの設定 および Java チュートリアル: プーリング を参照してください。

5.4.2. LDAP レルムのユーザー認証方法

LDAP レルムでのユーザー認証方法を設定します。

LDAP レルムは、次の 2 つの方法でユーザーを認証できます。

| ハッシュ化されたパスワードの比較 |

ユーザーのパスワード属性 (通常は |

| 直接検証 | 提供された認証情報を使用して、LDAP サーバーに対して認証を行います。

Active Directory で機能する唯一の方法は直接検証です。 |

direct-verification 属性でハッシュ化を実行するエンドポイントの認証メカニズムは使用できません。この方法ではクリアテキストのパスワードが必要であるためです。そのため、Active Directory Server と統合するには、REST エンドポイントでは BASIC 認証メカニズムを、Hot Rod エンドポイントでは PLAIN を使用する必要があります。より安全な代替方法として、SPNEGO、GSSAPI、および GS2-KRB5 認証メカニズムを可能にする Kerberos を使用することができます。

LDAP レルムはディレクトリーを検索して、認証されたユーザーに対応するエントリーを探し出します。rdn-identifier 属性は、指定された識別子 (通常はユーザー名) をもとにユーザーエントリーを検索する LDAP 属性を指定します (例: uid または sAMAccountName 属性)。search-recursive="true" を設定に追加して、ディレクトリーを再帰的に検索します。デフォルトでは、ユーザーエントリーの検索は (rdn_identifier={0}) フィルターを使用します。filter-name 属性を使用して、別のフィルターを指定できます。

5.4.3. ユーザーエントリーの関連グループへのマッピング

LDAP レルム設定で attribute-mapping 要素を指定して、ユーザーがメンバーであるすべてのグループを取得して関連付けます。

メンバーシップ情報は通常、次の 2 つの方法で保存されます。

-

通常

member属性にクラスgroupOfNamesまたはgroupOfUniqueNamesを持つグループエントリーの下。これは、Active Directory を除く、ほとんどの LDAP インストールにおけるデフォルトの動作です。この場合、属性フィルターを使用できます。このフィルターは、提供されたフィルターに一致するエントリーを検索します。フィルターは、ユーザーの DN と等しいmember属性を持つグループを検索します。次に、フィルターは、fromで指定されたグループエントリーの CN を抽出し、それをユーザーのRolesに追加します。 memberOf属性のユーザーエントリー内。これは通常、Active Directory の場合に当てはまります。この場合、以下のような属性参照を使用する必要があります。<attribute-reference reference="memberOf" from="cn" to="Roles" />この参照は、ユーザーのエントリーからすべての

memberOf属性を取得し、fromで指定された CN を抽出し、それらをユーザーのグループに追加します (Rolesはグループのマッピングに使用される内部名です)。

5.4.4. LDAP レルム設定リファレンス

XML

JSON

YAML

5.4.4.1. LDAP レルムプリンシパルの書き換え

GSSAPI、GS2-KRB5、Negotiate などの SASL 認証メカニズムによって取得されるプリンシパルには、通常、ドメイン名 (例: myuser@INFINISPAN.ORG) が含まれます。これらのプリンシパルを LDAP クエリーで使用する前に、プリンシパルを変換して互換性を確保する必要があります。このプロセスは書き換えと呼ばれます。

Data Grid には次のトランスフォーマーが含まれています。

| case-principal-transformer |

プリンシパルをすべて大文字またはすべて小文字に書き換えます。たとえば |

| common-name-principal-transformer |

プリンシパルを LDAP 識別名形式 (RFC 4514 で定義) に書き換えます。タイプ |

| regex-principal-transformer | キャプチャーグループを含む正規表現を使用してプリンシパルを書き換え、たとえば、任意の部分文字列の抽出を可能にします。 |

5.4.4.2. LDAP プリンシパル書き換え設定リファレンス

ケースプリンシパルトランスフォーマー

XML

JSON

YAML

コモンネームプリンシパルトランスフォーマー

XML

JSON

YAML

Regex プリンシパルトランスフォーマー

XML

JSON

YAML

5.4.4.3. Data Grid を使用した LDAP ユーザーとグループのマッピングプロセス

この例では、LDAP ユーザーとグループをロードし、Data Grid サブジェクトに内部マッピングするプロセスを示します。以下は、複数の LDAP エントリーを記述した LDIF (LDAP Data Interchange Format) ファイルです。

LDIF

root ユーザーは、admin および monitor グループのメンバーです。

エンドポイントの 1 つでパスワード strongPassword を使用してユーザー root を認証するよう要求されると、次の操作が実行されます。

- ユーザー名は、選択されたプリンシパルトランスフォーマーを使用して、必要に応じて書き換えられます。

-

レルムは、

uid属性がrootに等しいエントリーをou=People,dc=infinispan,dc=orgツリー内で検索し、DNuid=root,ou=People,dc=infinispan,dc=orgのエントリーを探し出します。このエントリーがユーザープリンシパルになります。 -

レルムは、

u=Roles,dc=infinispan,dc=orgツリー内で、member属性にuid=root,ou=People,dc=infinispan,dc=orgを含むobjectClass=groupOfNamesのエントリーを検索します。この場合、cn=admin,ou=Roles,dc=infinispan,dc=orgとcn=monitor,ou=Roles,dc=infinispan,dc=orgの 2 つのエントリーが見つかります。これらのエントリーから、グループプリンシパルとなるcn属性を抽出します。

したがって、結果として得られるサブジェクトは次のようになります。

-

NamePrincipal:

uid=root,ou=People,dc=infinispan,dc=org -

RolePrincipal:

admin -

RolePrincipal:

monitor

この時点で、グローバル承認マッパーが上記のサブジェクトに適用され、プリンシパルがロールに変換されます。その後、ロールが一連のパーミッションに展開され、パーミッションが要求されたキャッシュと操作に対して検証されます。

5.5. トークンレルム

トークンレルムは外部サービスを使用してトークンを検証し、Red Hat SSO などの RFC-7662 (OAuth2 トークンイントロスペクション) と互換性のあるプロバイダーを必要とします。

トークンレルムの設定

XML

JSON

YAML

5.6. トラストストアレルム

トラストストアレルムは、接続のネゴシエート時に Data Grid Server およびクライアント ID を検証する証明書または証明書チェーンを使用します。

- キーストア

- Data Grid Server アイデンティティーをクライアントに提供するサーバー証明書が含まれます。サーバー証明書でキーストアを設定する場合、Data Grid Server は業界標準の SSL/TLS プロトコルを使用してトラフィックを暗号化します。

- トラストストア

- クライアントが Data Grid Server に提示するクライアント証明書または証明書チェーンが含まれます。クライアントのトラストストアはオプションで、Data Grid Server がクライアント証明書認証を実行できるようになっています。

クライアント証明書認証

Data Grid Server でクライアント証明書を検証または認証する場合は、require-ssl-client-auth="true" 属性をエンドポイント設定に追加する必要があります。

トラストストアレルムの設定

XML

JSON

YAML

5.7. 分散セキュリティーレルム

分散レルムは、複数のタイプのセキュリティーレルムを組み合わせます。ユーザーが Hot Rod または REST エンドポイントにアクセスしようとすると、認証を実行できるものを見つけるまで、Data Grid Server は各セキュリティーレルムを順番に使用します。

分散レルムの設定

XML

JSON

YAML

5.8. 集約セキュリティーレルム

集約レルムは複数のレルムを組み合わせます。最初のレルムは認証手順用で、他のレルムは認可手順のアイデンティティーをロードするためのものです。たとえば、これを使用して、クライアント証明書を介してユーザーを認証し、プロパティーまたは LDAP レルムからアイデンティティーを取得できます。

集約レルムの設定

XML

JSON

YAML

5.8.1. 名前リライター

プリンシパル名の形式は、セキュリティーレルムの種類に応じて異なります。

- プロパティーとトークンレルムは、単純な文字列を返す場合があります

- 信頼と LDAP レルムは X.500 形式の識別名を返す場合があります

-

Kerberos レルムは

user@domain形式の名前を返す場合があります

次のいずれかのトランスフォーマーを使用して集約レルムを使用する場合は、名前を共通形式に正規化する必要があります。

5.8.1.1. ケースプリンシパルトランスフォーマー

case-principal-transformer は、名前をすべて大文字またはすべて小文字に変換します。

XML

<aggregate-realm authentication-realm="trust" authorization-realms="properties">

<name-rewriter>

<case-principal-transformer uppercase="false"/>

</name-rewriter>

</aggregate-realm>

<aggregate-realm authentication-realm="trust" authorization-realms="properties">

<name-rewriter>

<case-principal-transformer uppercase="false"/>

</name-rewriter>

</aggregate-realm>JSON

YAML

5.8.1.2. コモンネームプリンシパルトランスフォーマー

common-name-principal-transformer は、LDAP または証明書によって使用される DN から最初の CN 要素を抽出します。たとえば、CN=app1,CN=serviceA,OU=applications,DC=infinispan,DC=org 形式のプリンシパルが指定されている場合、次の設定では app1 がプリンシパルとして抽出されます。

XML

<aggregate-realm authentication-realm="trust" authorization-realms="properties">

<name-rewriter>

<common-name-principal-transformer/>

</name-rewriter>

</aggregate-realm>

<aggregate-realm authentication-realm="trust" authorization-realms="properties">

<name-rewriter>

<common-name-principal-transformer/>

</name-rewriter>

</aggregate-realm>JSON

YAML

5.8.1.3. Regex プリンシパルトランスフォーマー

regex-principal-transformer は、 正規表現を使用して検索と置換を実行できます。この例では、user@domain.com 識別子からローカル部分を抽出する方法を示します。

XML

<aggregate-realm authentication-realm="trust" authorization-realms="properties">

<name-rewriter>

<regex-principal-transformer pattern="([^@]+)@.*" replacement="$1" replace-all="false"/>

</name-rewriter>

</aggregate-realm>

<aggregate-realm authentication-realm="trust" authorization-realms="properties">

<name-rewriter>

<regex-principal-transformer pattern="([^@]+)@.*" replacement="$1" replace-all="false"/>

</name-rewriter>

</aggregate-realm>JSON

YAML

5.9. セキュリティーレルムのキャッシュ

セキュリティーレルムは、通常は非常にまれに変更されるデータを繰り返し取得する必要を回避するためにキャッシュを実装します。デフォルトでは、以下のようになります。

レルムキャッシュレルム設定

XML

JSON

YAML

5.9.1. レルムキャッシュのフラッシュ

CLI を使用して、クラスター全体のセキュリティーレルムキャッシュをフラッシュします。

[node-1@mycluster//containers/default]> server aclcache flush

[node-1@mycluster//containers/default]> server aclcache flush第6章 TLS/SSL 暗号化の設定

Data Grid の公開鍵と秘密鍵が含まれるキーストアを設定することにより、SSL/TLS 暗号化を使用して Data Grid Server の接続をセキュアにすることができます。相互 TLS が必要な場合、クライアント証明書認証を設定することもできます。

6.1. Data Grid Server キーストアの設定

キーストアを Data Grid Server に追加し、その ID をクライアントに対して検証する SSL/TLS 証明書を提示します。セキュリティーレルムに TLS/SSL アイデンティティーが含まれる場合は、そのセキュリティーレルムを使用する Data Grid Server エンドポイントへの接続を暗号化します。

前提条件

- Data Grid Server の証明書または証明書チェーンが含まれるキーストアを作成します。

Data Grid Server は、JKS、JCEKS、PKCS12/PFX、および PEM のキーストア形式をサポートします。Bouncy Castle ライブラリーが存在する場合は、BKS、BCFKS、および UBER もサポートされます。

証明書には、RFC 2818 仕様で定義されたルールに従って、クライアントがホスト名の検証を正しく実行できるように、dNSName および/または iPAddress タイプの subjectAltName 拡張が含まれている必要があります。このような拡張子を含まない証明書を使用してサーバーを起動すると、警告が発行されます。

実稼働環境では、サーバー証明書は Root または Intermediate CA のいずれかの信頼される認証局によって署名される必要があります。

以下のいずれかが含まれる場合には、PEM ファイルをキーストアとして使用できます。

- PKCS#1 または PKCS#8 形式の秘密鍵。

- 1 つ以上の証明書。

PEM ファイルキーストアを空のパスワード (password="") で設定する必要があります。

手順

- Data Grid Server 設定を開いて編集します。

-

Data Grid Server の SSL/TLS アイデンティティーが含まれるキーストアを

$RHDG_HOME/server/confディレクトリーに追加します。 -

server-identities定義を Data Grid Server セキュリティーレルムに追加します。 -

path属性でキーストアファイル名を指定します。 -

キーストアパスワードと証明書エイリアスに

keystore-passwordおよびalias属性を指定します。 - 変更を設定に保存します。

次のステップ

クライアントが Data Grid Server の SSL/TLS ID を確認できるように、トラストストアを使用してクライアントを設定します。

キーストアの設定

XML

JSON

YAML

6.1.1. SSL/TLS 証明書のローテーション

SSL/TLS 証明書には有効期限があり、有効期限を過ぎると無効になります。証明書を更新するプロセスは、"ローテーション" とも呼ばれます。Data Grid はキーストアファイルの変更を監視し、サーバーまたはクライアントを再起動せずに自動的に再読み込みします。

証明書のローテーション中にシームレスな操作を確実に行うには、認証局 (CA) によって署名された証明書を使用し、CA 証明書を使用してサーバーおよびクライアントの両方のトラストストアを設定します。自己署名証明書を使用すると、すべてのクライアントとサーバーが更新されるまで、一時的なハンドシェイクエラーが発生します。

6.1.2. Data Grid Server キーストアの生成

起動時にキーストアを自動的に生成するように Data Grid Server を設定します。

自動生成されたキーストア:

- 実稼働環境では使用しないでください。

- 必要に応じて生成されます。たとえば、クライアントから最初の接続を取得する際などに生成されます。

- Hot Rod クライアントで直接使用可能な証明書が含まれます。

手順

- Data Grid Server 設定を開いて編集します。

-

サーバー設定に

keystore要素のgenerate-self-signed-certificate-host属性を含めます。 - サーバー証明書のホスト名を値として指定します。

- 変更を設定に保存します。

生成されたキーストアの設定

XML

JSON

YAML

6.1.3. TLS バージョンおよび暗号スイートの設定

SSL/TLS 暗号化を使用してデプロイメントのセキュリティーを保護する場合は、特定のバージョンの TLS プロトコルと、プロトコル内の特定の暗号スイートを使用するように Data Grid Server を設定できます。

手順

- Data Grid Server 設定を開いて編集します。

-

engine要素を Data Grid Server の SSL 設定に追加します。 enabled-protocols属性を持つ 1 つ以上の TLS バージョンを使用するように Data Grid を設定します。Data Grid Server は、デフォルトで TLS バージョン 1.2 および 1.3 をサポートします。該当する場合は、クライアント接続のセキュリティープロトコルを制限するために、

TLSv1.3のみを設定できます。Data Grid は、TLSv1.1の有効化を推奨していません。これは、サポートが制限された古いプロトコルで、セキュリティー保護が弱いからです。1.1 より古いバージョンの TLS を有効にすることはできません。警告Data Grid Server の SSL

engine設定を変更する場合は、enabled-protocols属性を使用して TLS バージョンを明示的に設定する必要があります。enabled-protocols属性を省略すると、すべての TLS バージョンが許可されます。<engine enabled-protocols="TLSv1.3 TLSv1.2" />

<engine enabled-protocols="TLSv1.3 TLSv1.2" />Copy to Clipboard Copied! Toggle word wrap Toggle overflow enabled-ciphersuites属性 (TLSv1.2 以下) およびenabled-ciphersuites-tls13属性 (TLSv1.3) を使用して、1 つまたは複数の暗号スイートを使用するように Data Grid を設定します。使用する予定のプロトコル機能 (例:

HTTP/2 ALPN) をサポートする暗号スイートを設定していることを確認する必要があります。- 変更を設定に保存します。

SSL エンジンの設定

XML

JSON

YAML

6.2. FIPS 140-2 準拠の暗号を使用するシステムでの Data Grid Server の設定

FIPS (Federal Information Processing Standards) とは、米国連邦政府のコンピューターシステムの標準およびガイドラインです。FIPS は米国連邦政府が使用するために開発されたものですが、民間部門の多くは自発的にこれらの標準を使用しています。

FIPS 140-2 は、暗号モジュールに対するセキュリティー要件を定義しています。代替の JDK セキュリティープロバイダーを使用することで、FIPS 140-2 仕様に準拠する暗号化方式を使用するように Data Grid Server を設定することができます。

6.2.1. PKCS11 暗号プロバイダーの設定

SunPKCS11-NSS-FIPS プロバイダーで PKCS11 キーストアを指定すると、PKCS11 暗号化プロバイダーを設定できます。

前提条件

-

FIPS モード用にシステムを設定する。システムが FIPS モードを有効にしているかどうかは、Data Grid のコマンドラインインターフェイス (CLI) で

fips-mode-setup --checkコマンドを発行することで確認できます。 -

certutilツールを使用して、システム全体の NSS データベースを初期化します。 -

SunPKCS11プロバイダーを有効にするようにjava.securityファイルを設定した JDK をインストールします。このプロバイダーは、NSS データベースと SSL プロバイダーを指します。 - NSS データベースに証明書をインストールします。

手順

- Data Grid Server 設定を開いて編集します。

-

server-identities定義を Data Grid Server セキュリティーレルムに追加します。 -

SunPKCS11-NSS-FIPSプロバイダーで PKCS11 キーストアを指定します。 - 変更を設定に保存します。

キーストアの設定

XML

JSON

YAML

6.2.2. Bouncy Castle FIPS 暗号プロバイダーの設定

Bouncy Castle FIPS (Federal Information Processing Standards) 暗号化プロバイダーは、Data Grid サーバーの設定で設定することができます。

前提条件

-

FIPS モード用にシステムを設定する。システムが FIPS モードを有効にしているかどうかは、Data Grid のコマンドラインインターフェイス (CLI) で

fips-mode-setup --checkコマンドを発行することで確認できます。 - 証明書を含む BCFKS 形式のキーストアを作成します。

手順

-

Bouncy Castle FIPS JAR ファイルをダウンロードし、Data Grid Server のインストール先の

server/libディレクトリーにファイルを追加してください。 Bouncy Castle をインストールするには、

installコマンドを実行します。[disconnected]> install org.bouncycastle:bc-fips:1.0.2.3

[disconnected]> install org.bouncycastle:bc-fips:1.0.2.3Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Data Grid Server 設定を開いて編集します。

-

server-identities定義を Data Grid Server セキュリティーレルムに追加します。 -

BCFIPSプロバイダーで BCFKS キーストアを指定します。 - 変更を設定に保存します。

キーストアの設定

XML

JSON

YAML

6.3. クライアント証明書認証の設定

Data Grid Server が相互 TLS を使用してクライアント接続のセキュリティーを保護するように設定します。

トラストストアの証明書からクライアント ID を検証するように Data Grid を設定するには、以下の 2 つの方法があります。

- 通常は認証局 (CA) である署名証明書のみが含まれるトラストストアが必要です。CA によって署名された証明書を提示するクライアントは、Data Grid に接続できます。

- 署名証明書に加えて、すべてのクライアント証明書が含まれるトラストストアが必要です。トラストストアに存在する署名済み証明書を提示するクライアントのみが Data Grid に接続できます。

トラストストアを提供する代わりに、共有システム証明書を使用できます。

前提条件

- CA 証明書またはすべての公開証明書のいずれかを含むクライアントトラストストアを作成します。

- Data Grid Server のキーストアを作成し、SSL/TLS アイデンティティーを設定します。

PEM ファイルは、1 つ以上の証明書が含まれるトラストストアとして使用できます。これらのトラクトストアは、空のパスワード password="" で設定する必要があります。

手順

- Data Grid Server 設定を開いて編集します。

-

require-ssl-client-auth="true"パラメーターをendpoints設定に追加します。 -

クライアントトラストストアを

$RHDG_HOME/server/confディレクトリーに追加します。 -

Data Grid Server セキュリティーレルム設定で、

truststore要素のpathおよびpassword属性を指定します。 -

Data Grid Server で各クライアント証明書を認証する場合は、

<truststore-realm/>要素をセキュリティーレルムに追加します。 - 変更を設定に保存します。

次のステップ

- セキュリティーロールおよびパーミッションでアクセスを制御する場合は、Data Grid Server 設定で、クライアント証明書を使用して承認を設定します。

- クライアントを設定し、Data Grid Server と SSL/TLS 接続をネゴシエートします。

クライアント証明書認証設定

XML

JSON

YAML

6.4. クライアント証明書を使用した承認の設定

クライアント証明書認証を有効にすると、クライアント設定で Data Grid ユーザー認証情報を指定する必要がなくなります。つまり、ロールをクライアント証明書の Common Name (CN) フィールドに関連付ける必要があります。

前提条件

- クライアントに、公開証明書または証明書チェーンの一部 (通常は公開 CA 証明書) のいずれかが含まれる Java キーストアを提供します。

- クライアント証明書認証を実行するように Data Grid Server を設定します。

手順

- Data Grid Server 設定を開いて編集します。

-

セキュリティー承認設定で

common-name-role-mapperを有効にします。 -

クライアント証明書から Common Name (

CN) に、適切な権限を持つロールを割り当てます。 - 変更を設定に保存します。

Data Grid は、証明書プリンシパルを抽出してクライアントのアイデンティティーを作成します。証明書内に存在する可能性のあるその他のサブジェクト代替名 (SAN) は現在無視されます。このため、以下の authorization.group-only-mapping 属性を false に設定する必要があります。

クライアント証明書承認設定

XML

JSON

YAML

第7章 キーストアへの Data Grid Server 認証情報の保存

外部サービスには、Data Grid Server での認証に認証情報が必要です。パスワードなどの機密なテキスト文字列を保護するには、これらを Data Grid Server 設定ファイルに直接追加するのではなく、認証情報キーストアに追加します。

次に、データベースや LDAP ディレクトリーなどのサービスと接続を確立するためのパスワードを復号化するように、Data Grid Server を設定することができます。

$RHDG_HOME/server/conf のプレーンテキストのパスワードは暗号化されません。ホストファイルシステムへの読み取りアクセス権を持つすべてのユーザーアカウントは、プレーンテキストのパスワードを表示できます。

認証情報キーストアはパスワードで保護されたストア暗号化パスワードですが、ホストファイルシステムへの書き込みアクセス権を持つユーザーアカウントは、キーストア自体を改ざんすることが可能です。

Data Grid Server の認証情報を完全に保護するには、Data Grid Server を設定および実行できるユーザーアカウントにのみ読み書きアクセスを付与する必要があります。

7.1. 認証情報キーストアのセットアップ

Data Grid Server アクセスの認証情報を暗号化するキーストアを作成します。

認証情報キーストアには、暗号化されたパスワードに関連するエイリアスが少なくとも 1 つ含まれます。キーストアの作成後に、データベース接続プールなどの接続設定にエイリアスを指定します。その後、Data Grid Server は、サービスが認証を試行するときに、キーストアからそのエイリアスのパスワードを復号化します。

必要な数のエイリアスを使用して、必要な数の認証情報キーストアを作成できます。

セキュリティーのベストプラクティスとして、キーストアは Data Grid Server のプロセスを実行するユーザーのみが読み取れるようにする必要があります。

手順

-

$RHDG_HOMEでターミナルを開きます。 キーストアを作成し、

credentialsコマンドを使用して認証情報を追加します。ヒントデフォルトでは、キーストアのタイプは PKCS12 です。キーストアのデフォルトの変更に関する詳細は、

help credentialsを実行します。次の例は、パスワード "changeme" 用に "dbpassword" のエイリアスを含むキーストアを作成する方法を示しています。キーストアの作成時に、

-p引数を使用してキーストアにアクセスするためのパスワードも指定します。- Linux

bin/cli.sh credentials add dbpassword -c changeme -p "secret1234!"

bin/cli.sh credentials add dbpassword -c changeme -p "secret1234!"Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Microsoft Windows

bin\cli.bat credentials add dbpassword -c changeme -p "secret1234!"

bin\cli.bat credentials add dbpassword -c changeme -p "secret1234!"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

エイリアスがキーストアに追加されていることを確認します。

bin/cli.sh credentials ls -p "secret1234!" dbpassword

bin/cli.sh credentials ls -p "secret1234!" dbpasswordCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Data Grid Server 設定を開いて編集します。

認証情報キーストアを使用するように Data Grid を設定します。

-

security設定にcredential-storesセクションを追加します。 - 認証情報キーストアの名前と場所を指定します。

clear-text-credentialの設定で、認証情報キーストアにアクセスするためのパスワードを指定します。注記Data Grid Server 設定に認証情報キーストアのクリアテキストパスワードを追加する代わりに、外部コマンドまたはマスクされたパスワードを使用して、セキュリティーを強化することができます。

また、ある認証情報ストアのパスワードを、別の認証情報ストアのマスターパスワードとして使用することもできます。

-

Data Grid Server がデータソースや LDAP サーバーなどの外部システムとの接続に使用する設定において、認証情報キーストアを参照します。

-

credential-referenceセクションを追加します。 -

store属性で、認証情報キーストアの名前を指定します。 alias属性でパスワードのエイリアスを指定します。ヒントcredential-reference設定の属性はオプションです。-

storeは、複数のキーストアがある場合にのみ必要です。 -

aliasは、キーストアに複数のパスワードエイリアスが含まれている場合にのみ必要です。

-

-

- 変更を設定に保存します。

7.2. 認証情報キーストアのパスワードの保護

Data Grid Server では、認証情報キーストアにアクセスするためにパスワードが必要です。そのパスワードをキリアテキストで Data Grid Server の設定に追加するか、セキュリティー強化として、パスワードに外部コマンドを使用したり、パスワードをマスクしたりすることができます。

前提条件

- Data Grid Server に認証情報キーストアを設定している。

手順

次のいずれかを行います。

credentials maskコマンドを使用して、パスワードが明らかにならないようにします。以下に例を示します。bin/cli.sh credentials mask -i 100 -s pepper99 "secret1234!"

bin/cli.sh credentials mask -i 100 -s pepper99 "secret1234!"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Masked パスワードは Password Based Encryption (PBE) を使用し、Data Grid Server 設定では次の形式である必要があります: <MASKED_VALUE;SALT;ITERATION>

標準出力としてパスワードを提供する外部コマンドを使用します。

外部コマンドは、シェルスクリプトやバイナリーなど、

java.lang.Runtime#exec(java.lang.String)を使用する任意の実行可能ファイルにすることができます。

コマンドにパラメーターが必要な場合は、スペースで区切られた文字列のリストで指定します。

7.3. 認証情報キーストアの設定

Data Grid Server の設定に認証情報キーストアを追加し、クリアテキストのパスワード、マスクされたパスワード、またはパスワードを供給する外部コマンドを使用することができます。

クリアテキストパスワードを持つ認証情報キーストア

XML

JSON

YAML

パスワードがマスクされた認証情報キーストア

XML

JSON

YAML

外部コマンドのパスワード

XML

JSON

YAML

7.4. 認証情報キーストア参照

Data Grid Server に認証情報キーストアを追加すると、接続設定でそれらを参照することができます。

データソース接続

XML

JSON

YAML

LDAP 接続

XML

JSON

YAML

第8章 ロールベースアクセス制御によるセキュリティー承認

ロールベースアクセス制御 (RBAC) 機能では、さまざまなパーミッションレベルを使用して、Data Grid とのユーザーの対話を制限します。

リモートキャッシュまたは組み込みキャッシュに固有のユーザーの作成と承認の設定に関する詳細は、以下を参照してください。

8.1. Data Grid のユーザーロールと権限

Data Grid には、キャッシュや Data Grid のリソースにアクセスするための権限をユーザーに提供するロールがいくつかあります。

| Role | パーミッション | 説明 |

|---|---|---|

|

| すべて | Cache Manager ライフサイクルの制御など、すべてのパーミッションを持つスーパーユーザー。 |

|

| ALL_READ、ALL_WRITE、LISTEN、EXEC、MONITOR、CREATE |

|

|

| ALL_READ、ALL_WRITE、LISTEN、EXEC、MONITOR |

|

|

| ALL_READ、MONITOR |

|

|

| MONITOR |

JMX および |

8.1.1. パーミッション

ユーザーロールは、さまざまなアクセスレベルを持つパーミッションのセットです。

| パーミッション | 機能 | 説明 |

| 設定 |

| 新しいキャッシュ設定を定義します。 |

| LISTEN |

| Cache Manager に対してリスナーを登録します。 |

| ライフサイクル |

| Cache Manager を停止します。 |

| CREATE |

| キャッシュ、カウンター、スキーマ、スクリプトなどのコンテナーリソースを作成および削除することができます。 |

| MONITOR |

|

JMX 統計および |

| すべて | - | すべての Cache Manager のアクセス許可が含まれます。 |

| パーミッション | 機能 | 説明 |

| READ |

| キャッシュからエントリーを取得します。 |

| WRITE |

| キャッシュ内のデータの書き込み、置換、削除、エビクト。 |

| EXEC |

| キャッシュに対するコードの実行を許可します。 |

| LISTEN |

| キャッシュに対してリスナーを登録します。 |

| BULK_READ |

| 一括取得操作を実行します。 |

| BULK_WRITE |

| 一括書き込み操作を実行します。 |

| ライフサイクル |

| キャッシュを開始および停止します。 |

| ADMIN |

| 基盤となるコンポーネントと内部構造へのアクセスを許可します。 |

| MONITOR |

|

JMX 統計および |

| すべて | - | すべてのキャッシュパーミッションが含まれます。 |

| ALL_READ | - | READ パーミッションと BULK_READ パーミッションを組み合わせます。 |

| ALL_WRITE | - | WRITE パーミッションと BULK_WRITE パーミッションを組み合わせます。 |

8.1.2. ロールとパーミッションマッパー

Data Grid は、ユーザーをプリンシパルのコレクションとして実装します。プリンシパルは、ユーザー名などの個々のユーザー ID、またはユーザーが属するグループのいずれかを表します。内部的には、これらは javax.security.auth.Subject クラスで実装されます。

承認を有効にするには、プリンシパルをロール名にマップし、その後、ロール名を一連のパーミッションに展開する必要があります。

Data Grid には、セキュリティープリンシパルをロールに関連付ける PrincipalRoleMapper API と、ロールを特定のパーミッションに関連付ける RolePermissionMapper API が含まれています。

Data Grid は以下のロールおよびパーミッションのマッパーの実装を提供します。

- クラスターロールマッパー

- クラスターレジストリーにロールマッピングのプリンシパルを保存します。

- クラスターパーミッションマッパー

- ロールとパーミッションのマッピングをクラスターレジストリーに保存します。ユーザーのロールとパーミッションを動的に変更できます。

- ID ロールマッパー

- ロール名としてプリンシパル名を使用します。プリンシパル名のタイプまたはフォーマットはソースに依存します。たとえば、LDAP ディレクトリーでは、プリンシパル名を識別名 (DN) にすることができます。

- コモンネームロールマッパー

-

ロール名としてコモンネーム (CN) を使用します。このロールマッパーは、識別名 (DN) を含む LDAP ディレクトリーまたはクライアント証明書で使用できます。たとえば、

cn=managers,ou=people,dc=example,dc=comは、managersロールにマッピングされます。

デフォルトでは、プリンシパルとロールのマッピングは、グループを表すプリンシパルにのみ適用されます。authorization.group-only-mapping 設定属性を false に設定すると、ユーザープリンシパルのマッピングも実行するように Data Grid を設定できます。

8.1.2.1. Data Grid でのロールとパーミッションへのユーザーのマッピング

LDAP サーバーから DN のコレクションとして取得された次のユーザーを考えてみましょう。

CN=myapplication,OU=applications,DC=mycompany CN=dataprocessors,OU=groups,DC=mycompany CN=finance,OU=groups,DC=mycompany

CN=myapplication,OU=applications,DC=mycompany

CN=dataprocessors,OU=groups,DC=mycompany

CN=finance,OU=groups,DC=mycompanyコモンネームロールマッパー を使用すると、ユーザーは次のロールにマッピングされます。

dataprocessors finance

dataprocessors

financeData Grid には次のロール定義があります。

dataprocessors: ALL_WRITE ALL_READ finance: LISTEN

dataprocessors: ALL_WRITE ALL_READ

finance: LISTENユーザーには次のパーミッションが与えられます。

ALL_WRITE ALL_READ LISTEN

ALL_WRITE ALL_READ LISTEN8.1.3. ロールマッパーの設定

Data Grid は、デフォルトでクラスターロールマッパーとクラスターパーミッションマッパーを有効にします。ロールマッピングに別の実装を使用するには、ロールマッパーを設定する必要があります。

手順

- Data Grid 設定を開いて編集します。

- ロールマッパーを、Cache Manager 設定のセキュリティー許可の一部として宣言します。

- 変更を設定に保存します。

ロールマッパーの設定

XML

JSON

YAML

infinispan:

cacheContainer:

security:

authorization:

commonNameRoleMapper: ~

infinispan:

cacheContainer:

security:

authorization:

commonNameRoleMapper: ~8.1.4. クラスターのロールと権限マッパーの設定

クラスターロールマッパーは、プリンシパルとロール間の動的なマッピングを維持します。クラスター権限マッパーは、動的なロール定義セットを維持します。どちらの場合も、マッピングはクラスターレジストリーに保存され、ランタイム時に CLI または REST API を使用して操作できます。

前提条件

-

Data Grid に

ADMIN権限がある。 - Data Grid CLI を起動している。

- 実行中の Data Grid クラスターに接続している。

8.1.4.1. 新しいロールの作成

新しいロールを作成し、権限を設定します。

手順

user roles createコマンドを使用してロールを作成します。以下に例を示します。user roles create --permissions=ALL_READ,ALL_WRITE simple

user roles create --permissions=ALL_READ,ALL_WRITE simpleCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

user roles ls コマンドでユーザーに付与したロールを一覧表示します。

user roles ls ["observer","application","admin","monitor","simple","deployer"]

user roles ls

["observer","application","admin","monitor","simple","deployer"]

user roles describe コマンドを使用してロールを説明します。

user roles describe simple

{

"name" : "simple",

"permissions" : [ "ALL_READ","ALL_WRITE" ]

}

user roles describe simple

{

"name" : "simple",

"permissions" : [ "ALL_READ","ALL_WRITE" ]

}8.1.4.2. ユーザーへのロール付与

ユーザーにロールを割り当て、キャッシュ操作や Data Grid のリソースとのやり取りを行う権限を付与します。

同じロールを複数のユーザーに割り当て、それらの権限を一元管理する場合は、ユーザーではなくグループにロールを付与します。

前提条件

-

Data Grid に

ADMIN権限がある。 - Data Grid ユーザーを作成すること。

手順

- Data Grid への CLI 接続を作成します。

user roles grantコマンドでユーザーにロールを割り当てます。以下に例を示します。user roles grant --roles=deployer katie

user roles grant --roles=deployer katieCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

user roles ls コマンドでユーザーに付与したロールを一覧表示します。

user roles ls katie ["deployer"]

user roles ls katie

["deployer"]8.1.4.3. クラスターロールマッパー名リライター

デフォルトでは、プリンシパル名とロール間の厳密な文字列等価性を使用してマッピングが実行されます。ルックアップを実行する前に、プリンシパル名にトランスフォーメーションを適用するようにクラスターロールマッパーを設定することができます。

手順

- Data Grid 設定を開いて編集します。

- Cache Manager 設定のセキュリティー認可の一環として、クラスターロールマッパーの名前リライターを指定します。

- 変更を設定に保存します。

プリンシパル名の形式は、セキュリティーレルムの種類に応じて異なります。

- プロパティーとトークンレルムは、単純な文字列を返す場合があります

- 信頼と LDAP レルムは X.500 形式の識別名を返す場合があります

-

Kerberos レルムは

user@domain形式の名前を返す場合があります

次のいずれかのトランスフォーマーを使用して、名前を共通形式に正規化できます。

8.1.4.3.1. ケースプリンシパルトランスフォーマー

XML

JSON

YAML

8.1.4.3.2. Regex プリンシパルトランスフォーマー

XML

JSON

YAML

8.2. セキュリティー承認によるキャッシュの設定

キャッシュにセキュリティー承認を追加し、ロールベースアクセス制御 (RBAC) を実施することができます。これには、Data Grid ユーザーが、キャッシュ操作を実行するのに十分なレベルのパーミッションを持つロールを持っている必要があります。

前提条件

- Data Grid のユーザーを作成し、ロールを付与するか、グループに割り当てている。

手順

- Data Grid 設定を開いて編集します。

-

設定に

securityセクションを追加します。 authorization要素を使用して、ユーザーがキャッシュ操作を実行するために必要なロールを指定します。Cache Manager で定義されたすべてのロールを暗黙的に追加するか、ロールのサブセットを明示的に定義できます。

- 変更を設定に保存します。

暗黙的なロール設定

次の設定では、Cache Manager で定義されたすべてのロールが暗黙的に追加されます。

XML

<distributed-cache>

<security>

<authorization/>

</security>

</distributed-cache>

<distributed-cache>

<security>

<authorization/>

</security>

</distributed-cache>JSON

YAML

distributedCache:

security:

authorization:

enabled: true

distributedCache:

security:

authorization:

enabled: true明示的なロール設定

次の設定では、Cache Manager で定義されたロールのサブセットを明示的に追加しています。この場合、Data Grid は、設定されたロールのいずれかを持たないユーザーのキャッシュ操作を拒否します。

XML

<distributed-cache>

<security>

<authorization roles="admin supervisor"/>

</security>

</distributed-cache>

<distributed-cache>

<security>

<authorization roles="admin supervisor"/>

</security>

</distributed-cache>JSON

YAML

distributedCache:

security:

authorization:

enabled: true

roles: ["admin","supervisor"]

distributedCache:

security:

authorization:

enabled: true

roles: ["admin","supervisor"]第9章 Data Grid 統計および JMX 監視の有効化および設定

Data Grid は、JMX MBean をエクスポートしたり、Cache Manager およびキャッシュ統計を提供できます。

9.1. リモートキャッシュでの統計の有効化

Data Grid Server は、デフォルトのキャッシュマネージャーの統計を自動的に有効にします。ただし、キャッシュの統計を明示的に有効にする必要があります。

手順

- Data Grid 設定を開いて編集します。

-

statistics属性またはフィールドを追加し、trueを値として指定します。 - Data Grid 設定を保存して閉じます。

リモートキャッシュの統計

XML

<distributed-cache statistics="true" />

<distributed-cache statistics="true" />JSON

{

"distributed-cache": {

"statistics": "true"

}

}

{

"distributed-cache": {

"statistics": "true"

}

}YAML

distributedCache: statistics: true

distributedCache:

statistics: true9.2. Hot Rod クライアント統計の有効化

Hot Rod Java クライアントは、リモートキャッシュヒット、ニアキャッシュヒット、ミス、および接続プールの使用状況などの統計を提供できます。

手順

- Hot Rod Java クライアント設定を開いて編集します。

-

trueをstatisticsプロパティーの値として指定するか、statistics().enable()メソッドを呼び出します。 -

jmxおよびjmx_domainプロパティーを使用して Hot Rod クライアントの JMX MBean をエクスポートするか、jmxEnable()メソッドおよびjmxDomain()メソッドを呼び出します。 - クライアント設定を保存して閉じます。

Hot Rod Java クライアントの統計

ConfigurationBuilder

hotrod-client.properties

infinispan.client.hotrod.statistics = true infinispan.client.hotrod.jmx = true infinispan.client.hotrod.jmx_domain = my.domain.org

infinispan.client.hotrod.statistics = true

infinispan.client.hotrod.jmx = true

infinispan.client.hotrod.jmx_domain = my.domain.org9.3. Data Grid メトリックの設定

Data Grid は、あらゆる監視システムと互換性のあるメトリクスを生成します。

- ゲージは、書き込み操作または JVM アップタイムの平均数 (ナノ秒) などの値を指定します。

- ヒストグラムは、読み取り、書き込み、削除の時間などの操作実行時間の詳細を提供します。

デフォルトでは、Data Grid は統計を有効にするとゲージを生成しますが、ヒストグラムを生成するように設定することもできます。

Data Grid メトリックは、vendor スコープで提供されます。JVM に関連するメトリックは base スコープで提供されます。

手順

- Data Grid 設定を開いて編集します。

-

metrics要素またはオブジェクトをキャッシュコンテナーに追加します。 -

gauges属性またはフィールドを使用してゲージを有効または無効にします。 -

histograms属性またはフィールドでヒストグラムを有効または無効にします。 - クライアント設定を保存して閉じます。

メトリックの設定

XML

JSON

YAML

検証

Data Grid Server は、Prometheus などの監視ツールで収集できる統計情報を metrics エンドポイントを通じて公開します。統計が metrics エンドポイントにエクスポートされていることを確認するには、以下の操作を実行します。

Prometheus 形式

curl -v http://localhost:11222/metrics \ --digest -u username:password

curl -v http://localhost:11222/metrics \

--digest -u username:passwordOpenMetrics 形式

curl -v http://localhost:11222/metrics \ --digest -u username:password \ -H "Accept: application/openmetrics-text"

curl -v http://localhost:11222/metrics \

--digest -u username:password \

-H "Accept: application/openmetrics-text"Data Grid は、MicroProfile の JSON 形式でのメトリクスを提供しなくなりました。

9.4. JMX MBean の登録

Data Grid は、統計の収集と管理操作の実行に使用できる JMX MBean を登録できます。統計を有効にする必要もあります。そうしないと、Data Grid は JMX MBean のすべての統計属性に 0 値を提供します。

Data Grid がアプリケーションに埋め込まれており、リモート Data Grid サーバーが使用されていない場合にのみ、統計を収集するのに JMX Mbean を使用します。

リモート Data Grid サーバーから統計を収集するために JMX Mbean を使用する場合、JMX Mbean から受信したデータは、REST などの他の API から受信したデータと異なる場合があります。このような場合、他の API から受信したデータの方が正確です。

手順

- Data Grid 設定を開いて編集します。

-

jmx要素またはオブジェクトをキャッシュコンテナーに追加し、enabled属性またはフィールドの値としてtrueを指定します。 -

domain属性またはフィールドを追加し、必要に応じて JMX MBean が公開されるドメインを指定します。 - クライアント設定を保存して閉じます。

JMX の設定

XML

JSON

YAML

9.4.1. JMX リモートポートの有効化

一意のリモート JMX ポートを提供し、JMXServiceURL 形式の接続を介して Data Grid MBean を公開します。

Data Grid Server は、単一のポートエンドポイント経由で JMX をリモートで公開しません。JMX 経由で Data Grid Server にリモートでアクセスする場合は、リモートポートを有効にする必要があります。

次のいずれかの方法を使用して、リモート JMX ポートを有効にできます。

- Data Grid Server セキュリティーレルムの 1 つに対する認証を必要とするリモート JMX ポートを有効にします。

- 標準の Java 管理設定オプションを使用して、手動でリモート JMX ポートを有効にします。

前提条件

-

認証付きのリモート JMX の場合、デフォルトのセキュリティーレルムを使用して JMX 固有のユーザーロールを定義します。ユーザーが JMX リソースにアクセスするには、読み取り/書き込みアクセス権を持つ

controlRoleまたは読み取り専用アクセス権を持つmonitorRoleが必要です。Data Grid は、グローバルADMINおよびMONITOR権限を JMXcontrolRoleおよびmonitorRoleロールに自動的にマップします。

手順

次のいずれかの方法を使用して、リモート JMX ポートを有効にして Data Grid Server を起動します。

ポート

9999を介してリモート JMX を有効にします。bin/server.sh --jmx 9999

bin/server.sh --jmx 9999Copy to Clipboard Copied! Toggle word wrap Toggle overflow 警告SSL を無効にしてリモート JMX を使用することは、本番環境向けではありません。

起動時に以下のシステムプロパティーを Data Grid Server に渡します。

bin/server.sh -Dcom.sun.management.jmxremote.port=9999 -Dcom.sun.management.jmxremote.authenticate=false -Dcom.sun.management.jmxremote.ssl=false

bin/server.sh -Dcom.sun.management.jmxremote.port=9999 -Dcom.sun.management.jmxremote.authenticate=false -Dcom.sun.management.jmxremote.ssl=falseCopy to Clipboard Copied! Toggle word wrap Toggle overflow 警告認証または SSL なしでリモート JMX を有効にすることは安全ではなく、どのような環境でも推奨されません。認証と SSL を無効にすると、権限のないユーザーがサーバーに接続し、そこでホストされているデータにアクセスできるようになります。

9.4.2. Data Grid MBean

Data Grid は、管理可能なリソースを表す JMX MBean を公開します。

org.infinispan:type=Cache- キャッシュインスタンスに使用できる属性および操作。

org.infinispan:type=CacheManager- Data Grid キャッシュやクラスターのヘルス統計など、Cache Manager で使用できる属性および操作。

使用できる JMX MBean の詳細なリストおよび説明、ならびに使用可能な操作および属性は、Data Grid JMX Components のドキュメントを参照してください。

9.4.3. カスタム MBean サーバーでの MBean の登録

Data Grid には、カスタム MBeanServer インスタンスに MBean を登録するのに使用できる MBeanServerLookup インターフェイスが含まれています。

前提条件

-

getMBeanServer()メソッドがカスタム MBeanServer インスタンスを返すようにMBeanServerLookupの実装を作成します。 - JMX MBean を登録するように Data Grid を設定します。

手順

- Data Grid 設定を開いて編集します。

-

mbean-server-lookup属性またはフィールドを Cache Manager の JMX 設定に追加します。 -

MBeanServerLookup実装の完全修飾名 (FQN) を指定します。 - クライアント設定を保存して閉じます。

JMX MBean サーバールックアップの設定

XML

JSON

YAML

9.5. 状態遷移操作中のメトリクスのエクスポート

Data Grid がノード間で再配布するクラスター化されたキャッシュのタイムメトリクスをエクスポートできます。

ノードがクラスターに参加したりクラスターから離れたりするなど、クラスター化されたキャッシュトポロジーが変更されると、状態遷移操作が発生します。状態遷移操作中に、Data Grid は各キャッシュからメトリクスをエクスポートするため、キャッシュのステータスを判断できます。状態遷移は、Data Grid が各キャッシュからメトリクスをエクスポートできるように、属性をプロパティーとして公開します。

インバリデーションモードでは状態遷移操作を実行できません。

Data Grid は、REST API および JMX API と互換性のある時間メトリクスを生成します。

前提条件

- Data Grid メトリクスを設定します。

- 組み込みキャッシュやリモートキャッシュなど、キャッシュタイプのメトリクスを有効にします。

- クラスター化されたキャッシュトポロジーを変更して、状態遷移操作を開始します。

手順

以下の方法のいずれかを選択します。

- REST API を使用してメトリクスを収集するように Data Grid を設定します。

- JMX API を使用してメトリクスを収集するように Data Grid を設定します。

9.6. クロスサイトレプリケーションのステータスの監視

バックアップの場所のサイトステータスを監視して、サイト間の通信の中断を検出します。リモートサイトのステータスが offline に変わると、Data Grid はバックアップの場所へのデータのレプリケーションを停止します。データが同期しなくなるため、クラスターをオンラインに戻す前に不整合を修正する必要があります。

問題を早期に検出するには、クロスサイトのイベントの監視が必要です。以下の監視ストラテジーのいずれかを使用します。

REST API を使用したクロスサイトレプリケーションの監視

REST エンドポイントを使用して、すべてのキャッシュのクロスサイトレプリケーションのステータスを監視します。カスタムスクリプトを実装して REST エンドポイントをポーリングするか、以下の例を使用できます。

前提条件

- クロスサイトレプリケーションを有効にする。

手順

REST エンドポイントをポーリングするスクリプトを実装します。

以下の例は、Python スクリプトを使用して、5 秒ごとにサイトのステータスをポーリングする方法を示しています。

サイトのステータスが online から offline に変わったり、その逆の場合、関数 on_event が呼び出されます。

このスクリプトを使用する場合は、以下の変数を指定する必要があります。

-

USERNAMEおよびPASSWORD: REST エンドポイントにアクセスする権限を持つ Data Grid ユーザーのユーザー名およびパスワード。 -

POLL_INTERVAL_SEC: ポーリング間の秒数。 -

SERVERS: このサイトの Data Grid Server の一覧。このスクリプトには必要なのは、有効な応答が 1 つだけですが、フェイルオーバーを許可するためにリストが提供されています。 -

REMOTE_SITES: これらのサーバー上で監視するリモートサイトのリスト。 -

CACHES: 監視するキャッシュ名のリスト。

Prometheus メトリクスを使用したクロスサイトレプリケーションの監視

Prometheus およびその他の監視システムを使用すると、サイトのステータスが offline に変化したことを検出するアラートを設定できます。

クロスサイトレイテンシーメトリックを監視すると、発生する可能性のある問題を検出しやすくなります。

前提条件

- クロスサイトレプリケーションを有効にする。

手順

- Data Grid メトリクスを設定します。

Prometheus メトリクス形式を使用してアラートルールを設定します。

-

サイトの状態については、

onlineの場合は1を、offlineの場合は0を使用します。 exprフィールドには、vendor_cache_manager_default_cache_<cache name>_x_site_admin_<site name>_statusの形式を使用します。以下の例では、Prometheus は、NYC サイトが

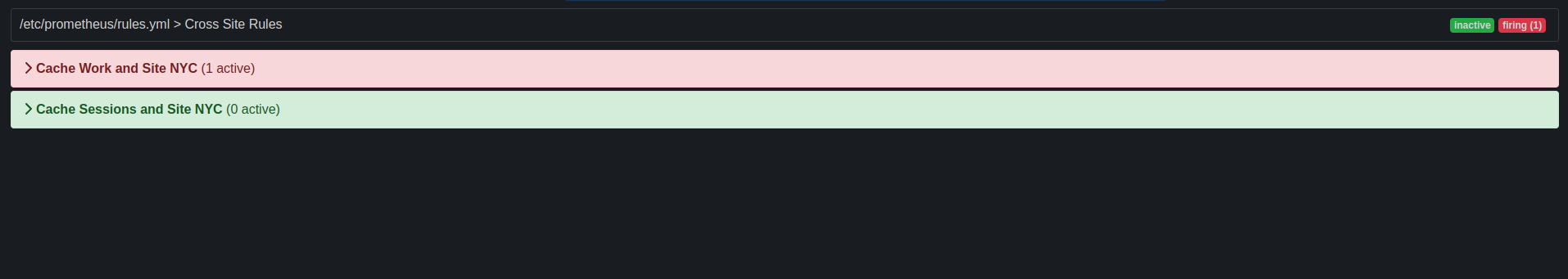

workまたはsessionsという名前のキャッシュに対してオフラインになると警告を表示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次の図は、NYC サイトがキャッシュ

workを行うためにofflineであるという警告を示しています。図9.1 Prometheus 警告

-

サイトの状態については、

第10章 Data Grid OpenTelemetry トレースの有効化と設定

Data Grid は、OpenTelemetry 標準に準拠したトレーススパンを生成し、最も重要なキャッシュ操作に関連するトレースデータをエクスポート、視覚化、分析できるようにします。

10.1. Data Grid トレースの設定

OpenTelemetry トレースを設定して、キャッシュ操作の監視とトレースを有効にします。

手順

- Data Grid 設定を開いて編集します。

-

トレース要素またはオブジェクトをキャッシュコンテナーに追加します。 -

collector_endpoint属性またはフィールドを使用して、OpenTelemetry コレクターのエンドポイント URL を定義します。トレースを有効にすることは必須です。4318は通常、http/protobufOTLP 標準ポートです。 -

enable属性またはフィールドを使用して、トレースをグローバルに有効または無効にします。 -

セキュリティー属性またはフィールドを使用して、セキュリティーイベントトレースを有効または無効にします。 -

必要に応じて、

exporter_protocol属性またはフィールドを変更して、トレースエクスポータープロトコルを変更します。デフォルトでは、otlp(OpenTelemetry プロトコル) です。 -

必要に応じて、

service_name属性またはフィールドを変更して、生成されたトレーススパンに関連付けられたトレースサービス名を変更します。デフォルトでは、infinispan-serverです。 - クライアント設定を保存して閉じます。

次のステップ

グローバルトレース設定の変更を適用するには、サーバーを停止して手順を繰り返します。

トレース設定

Data Grid は、トレース設定をすべてのキャッシュにグローバルに適用します。

XML

JSON

YAML

10.1.1. さらなるトレースオプション

さらなるトレースオプションを設定するには、起動時にシステムプロパティーを渡すか、環境変数を Data Grid サーバーに設定して、Data Grid サーバーが OpenTelemetry トレースを設定するために使用する OpenTelemetry SDK Autoconfigure を直接設定することができます。

手順

起動時にシステムプロパティーを Data Grid Server に渡します。

次の例のように

-D<property-name>=<property-value>引数を使用します。bin/server.sh -Dotel.exporter.otlp.timeout=10000

bin/server.sh -Dotel.exporter.otlp.timeout=10000Copy to Clipboard Copied! Toggle word wrap Toggle overflow

トレースデータ形式

デフォルトでは、Data Grid サーバーは OTLP http/protobuf プロトコルを使用してトレースデータをエクスポートします。

tracing.properties

otel.exporter.otlp.protocol = http/protobuf

otel.exporter.otlp.protocol = http/protobuf

別のプロトコルを使用するには、JAR ファイルまたは依存関係を Data Grid Server インストールの $ISPN_HOME/server/lib ディレクトリーにコピーする必要があります。

10.2. キャッシュレベルでトレースを設定する

トレースが サーバーレベルで設定される と、すべてのキャッシュに対してデフォルトで自動的に有効になります。一方、トレースのキャッシュ設定レベルでは、キャッシュレベルおよび実行時にトレースを有効または無効にすることができます。

追跡カテゴリー

追跡可能なカテゴリーはいくつかあります。

- コンテナー: これらはすべて、replace、put、clear、getForReplace、remove 操作、size などの主要なキャッシュ操作。すべての取得操作を除きます。

- クラスター: 同じクラスター内の別のノードに複製される操作。

- X サイト。別の外部サイトに複製される操作。

- 永続性キャッシュストアやキャッシュローダーを介した永続化に関わるすべての操作。

各カテゴリーは、カテゴリー リスト属性にリストすることで、起動時または実行時に有効化/無効化できます。デフォルトでは、コンテナーカテゴリーのみが有効になっています。

セキュリティー監査イベントをトレースするための セキュリティー カテゴリーもあります。このカテゴリーは、イベントがキャッシュスコープだけでなく、さまざまなスコープ (キャッシュ、コンテナー、サーバー) を持つことができるため、キャッシュレベルだけでなくグローバルに設定されます。

特定のキャッシュのトレースを有効/無効にする

XML

<replicated-cache>

<tracing enabled="true" categories="container cluster x-site persistence" />

</replicated-cache>

<replicated-cache>

<tracing enabled="true" categories="container cluster x-site persistence" />

</replicated-cache>JSON

YAML

実行時にトレースを有効/無効にする

キャッシュレベルのトレース属性 enable は変更可能な属性です。つまり、Infinispan クラスターを再起動せずに実行時に変更できます。

変更可能な属性を変更するには、HotRod と REST API の両方を使用できます。

HotRod

remoteCacheManager.administration() .updateConfigurationAttribute(CACHE_A, "tracing.enabled", "false");

remoteCacheManager.administration()

.updateConfigurationAttribute(CACHE_A, "tracing.enabled", "false");REST

restClient.cache(CACHE_A)

.updateConfigurationAttribute("tracing.enabled", "false");

restClient.cache(CACHE_A)

.updateConfigurationAttribute("tracing.enabled", "false");第11章 管理データソースの Data Grid Server への追加

管理データソースを Data Grid Server 設定に追加して、JDBC データベース接続の接続プールとパフォーマンスを最適化します。

11.1. マネージドデータソースの設定

Data Grid Server 設定の一部としてマネージドデータソースを作成し、JDBC データベース接続の接続プールとパフォーマンスを最適化します。その後、キャッシュ内のマネージドデータソースの JDNI 名を指定して、デプロイメントの JDBC 接続設定を一元化できます。

前提条件

データベースドライバーを、Data Grid Server インストールの

server/libディレクトリーにコピーします。ヒントData Grid コマンドラインインターフェイス (CLI) で

installコマンドを使用して、必要なドライバーをserver/libディレクトリーにダウンロードします。以下に例を示します。install org.postgresql:postgresql:42.4.3

install org.postgresql:postgresql:42.4.3Copy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

- Data Grid Server 設定を開いて編集します。

-

data-sourcesセクションに新しいdata-sourceを追加します。 -

name属性またはフィールドでデータソースを一意に識別します。 jndi-name属性またはフィールドを使用してデータソースの JNDI 名を指定します。ヒントJNDI 名を使用して、JDBC キャッシュストア設定でデータソースを指定します。

-

trueをstatistics属性またはフィールドの値に設定し、/metricsエンドポイント経由でデータソースの統計を有効にします。 connection-factoryセクションのデータソースへの接続方法を定義する JDBC ドライバーの詳細を提供します。-

driver属性またはフィールドを使用して、データベースドライバーの名前を指定します。 -