論理ボリュームマネージャの管理

Red Hat Enterprise Linux 6

LVM 管理者ガイド

概要

本ガイドは、クラスター化環境における LVM の実行に関する情報など、LVM 論理ボリュームマネージャについて説明しています。

第1章 はじめに

リンクのコピーリンクがクリップボードにコピーされました!

本ガイドは、クラスター化環境における LVM の実行に関する情報など、論理ボリュームマネージャ (LVM) について説明しています。

1.1. 対象読者

リンクのコピーリンクがクリップボードにコピーされました!

This book is intended to be used by system administrators managing systems running the Linux operating system. It requires familiarity with Red Hat Enterprise Linux 6.

1.2. ソフトウェアのバージョン

リンクのコピーリンクがクリップボードにコピーされました!

| ソフトウェア | 説明 |

|---|---|

|

Red Hat Enterprise Linux 6

|

Red Hat Enterprise Linux 6 以降を指します

|

|

GFS2

|

Red Hat Enterprise Linux 6 以降の GFS2 を指します

|

1.3. 関連ドキュメント

リンクのコピーリンクがクリップボードにコピーされました!

For more information about using Red Hat Enterprise Linux, see the following resources:

- 『インストールガイド』 — Red Hat Enterprise Linux 6 のインストールについての情報を記載しています。

- 『導入ガイド』 — Red Hat Enterprise Linux 6 の導入、設定、および管理に関する情報を提供します。

- 『ストレージ管理ガイド』 — Red Hat Enterprise Linux 6 上でのストレージデバイスおよびファイルシステムの効果的な管理方法について説明しています。

For more information about the High Availability Add-On and the Resilient Storage Add-On for Red Hat Enterprise Linux 6, see the following resources:

- 『High Availability アドオン概要』 — Red Hat High Availability アドオンの全体的な概要を説明しています。

- 『クラスターの管理』 — Red Hat High Availability アドオンのインストール、設定、および管理に関する情報を提供します。

- 『Global File System 2: 設定と管理』 — Resilient Storage アドオンに含まれている Red Hat GFS2 (Red Hat Global File System 2) のインストール、設定、および維持に関する情報を提供します。

- 『DM Multipath』 — Provides information about using the Device-Mapper Multipath feature of Red Hat Enterprise Linux 6.

- 『Load Balancer 管理』 — 実サーバー群全体にわたって IP 負荷を分散するための Linux Virtual Servers (LVS) を提供する、一式の統合ソフトウェアコンポーネントである Load Balancer アドオンを利用したハイパフォーマンスのシステムとサービスの設定に関する情報を提供します。

- 『リリースノート』 — Red Hat 製品の現在のリリースに関する情報を提供します。

Red Hat documents are available in HTML, PDF, and RPM versions on the Red Hat Enterprise Linux Documentation CD and online at https://access.redhat.com/site/documentation/.

1.4. フィードバック

リンクのコピーリンクがクリップボードにコピーされました!

誤字/脱字を発見された場合、もしくは本ガイドを改善するためのご意見/ご提案がございましたら、弊社にご連絡ください。その場合は、製品 Red Hat Enterprise Linux 6 およびコンポーネント doc-Logical_Volume_Manager に対して、Bugzilla (http://bugzilla.redhat.com/) 内でご報告ください。バグ報告を提出される時には、以下のマニュアルの識別子を必ずご記入いただくようお願いします。

Logical_Volume_Manager_Administration(EN)-6 (2017-3-8-15:20)

Logical_Volume_Manager_Administration(EN)-6 (2017-3-8-15:20)

If you have a suggestion for improving the documentation, try to be as specific as possible when describing it. If you have found an error, include the section number and some of the surrounding text so we can find it easily.

第2章 LVM 論理ボリュームマネージャ

リンクのコピーリンクがクリップボードにコピーされました!

この章では、Red Hat Enterprise Linux 6 の初期リリースならびにそれ以降のリリースに新たに組み込まれている LVM 論理ボリュームマネージャの機能についてまとめています。その後に、論理ボリュームマネージャ (LVM) のコンポーネントの概要を大まかに説明します。

2.1. 新機能および変更された機能

リンクのコピーリンクがクリップボードにコピーされました!

このセクションでは、Red Hat Enterprise Linux 6 の初期リリース以降に組み込まれている LVM 論理ボリュームマネージャの新機能および変更された機能について説明します。

2.1.1. Red Hat Enterprise Linux 6.0 で新規追加および変更された機能

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 6.0 では、ドキュメントと機能が以下のように更新/変更されています。

lvm.confファイルのactivationセクション内のmirror_image_fault_policyとmirror_log_fault_policyのパラメーターを使用して、デバイスに障害が発生した場合にミラー化論理ボリュームがどのように動作するかを定義することができます。このパラメーターがremoveに設定されている場合、システムは、障害の発生したデバイスを削除し、そのデバイスなしで稼働を試みます。このパラメーターがallocateに設定されている場合、システムは障害の発生したデバイスを削除し、そのデバイスの代わりとなる新たなデバイス上にスペースの割り当てを試みます。代わりとなる適切なデバイスとスペースを割り当てることができない場合、このポリシーはremoveと同様に機能します。LVM のミラー障害ポリシーに関する情報は、「ミラー化論理ボリュームの障害ポリシー」 をご覧ください。- Red Hat Enterprise Linux 6 リリースでは、Linux I/O スタックが強化され、ベンダーの提供する I/O 制限情報を処理できるようになりました。これによって、LVM を含むストレージ管理ツールでデータの配置とアクセスを最適化することができます。このサポートは、

lvm.confファイル内のdata_alignment_detectionとdata_alignment_offset_detectionのデフォルト値を変更することによって無効にすることが可能ですが、このサポートの無効化は推奨されません。LVM 内のデータ配置に関する情報ならびにdata_alignment_detectionとdata_alignment_offset_detectionのデフォルト値の変更に関する情報は、/etc/lvm/lvm.confファイルのインラインドキュメントをご覧ください。これは、付録B LVM 設定ファイル にも記載されています。Red Hat Enterprise Linux 6 における I/O スタックおよび I/O 制限のサポートに関する概説は、『ストレージ管理ガイド』 をご覧ください。 - Red Hat Enterprise Linux 6 では、デバイスマッパーが

udev統合に対する直接のサポートを提供します。これによって、デバイスマッパーは、LVM デバイスを含むすべてのデバイスマッパーデバイスに関連したすべてのudev処理と同期化されます。udevデバイスマネージャに対するデバイスマッパーのサポートに関する情報は、「デバイスマッパーの udev デバイスマネージャサポート」 をご覧ください。 - Red Hat Enterprise Linux 6 リリースでは、ディスク障害発生後に、

lvconvert --repairコマンドを使用してミラーを修復することができます。これによって、ミラーが一貫性のある状態に戻ります。lvconvert --repairコマンドに関する情報は、 「ミラー化論理ボリュームの修復」 をご覧ください。 - Red Hat Enterprise Linux 6 リリースでは、

lvconvertコマンドの--mergeオプションを使用してスナップショットを複製元のボリュームにマージすることができます。スナップショットのマージに関する情報は、「スナップショットボリュームのマージ」 をご覧ください。 - Red Hat Enterprise Linux 6 リリースでは、

lvconvertコマンドの--splitmirrors引数を使用してミラー化論理ボリュームの冗長イメージを分割して新たな論理ボリュームを形成することができます。このオプションの使用に関する情報は、「ミラー化論理ボリュームの冗長イメージの分割」 をご覧ください。 - ミラー化論理デバイスを作成する際に、

lvcreateコマンドの--mirrorlog mirrored引数を使用して、自動的にミラー化されるミラー化論理デバイスのミラーログを作成できるようになりました。このオプションの使用に関する情報は、「ミラー化ボリュームの作成」 をご覧ください。

2.1.2. Red Hat Enterprise Linux 6.1 で新規追加および変更された機能

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 6.1 では、ドキュメントと機能が以下のように更新/変更されています。

- Red Hat Enterprise Linux 6.1 リリースは、ミラー化論理ボリュームのスナップショット論理ボリューム作成をサポートしています。リニアまたはストライプ化された論理ボリュームの作成と同様に、ミラー化ボリュームのスナップショットを作成することができます。スナップショットボリュームの作成方法については、 「スナップショットボリュームの作成」 をご覧ください。

- LVM ボリュームを拡張する際には、

lvextendコマンドの--alloc clingオプションを使用して、cling割り当てポリシーを指定することができます。このポリシーによって、同一の物理ボリューム上のスペースが、既存の論理ボリュームの最終セグメントとして選択されます。物理ボリューム上に十分なスペースがなく、タグの一覧がlvm.confファイル内で定義されている場合には、LVM は、その物理ボリュームにいずれかのタグが付けられているかを確認し、既存エクステントと新規エクステント間で、物理ボリュームのタグを適合させようとします。lvextendコマンドで--alloc clingオプションを使用した LVM ミラー化ボリュームの拡張については、「cling割り当てポリシーを使用した論理ボリュームの拡張」 をご覧ください。 pvchange、vgchange、またはlvchangeの単一のコマンドで、--addtagおよび--deltagの引数を複数指定することができるようになりました。オブジェクトタグの追加と削除については、「オブジェクトタグの追加と削除」 をご覧ください。- LVM オブジェクトタグで使用可能な文字の一覧が拡大され、タグには "/"、"="、"!"、":"、"#"、および "&" の文字が使用できるようになりました。LVM オブジェクトタグについては、付録D LVM オブジェクトタグ をご覧ください。

- 単一の論理ボリューム内で RAID0 (ストライピング) と RAID1 (ミラーリング) の併用ができるようになりました。論理ボリュームの作成と同時にミラーの数 (

--mirrors X) とストライプの数 (--stripes Y) を指定すると、ミラーデバイスの構成デバイスがストライプ化されます。ミラー化論理ボリュームの作成については、「ミラー化ボリュームの作成」 をご覧ください。 - Red Hat Enterprise Linux 6.1 リリースでは、クラスター化されたボリューム上で恒常的なデータバックアップ作成が必要な場合、ボリュームを排他的にアクティブ化した上で、スナップショットを作成することができます。ノード上における論理ボリュームの排他的なアクティブ化についての情報については、「クラスター内の個別ノード上の論理ボリュームのアクティブ化」 をご覧ください。

2.1.3. Red Hat Enterprise Linux 6.2 で新規追加および変更された機能

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 6.2 では、ドキュメントと機能が以下のように更新/変更されています。

- The Red Hat Enterprise Linux 6.2 release supports the

issue_discardsparameter in thelvm.confconfiguration file. When this parameter is set, LVM will issue discards to a logical volume's underlying physical volumes when the logical volume is no longer using the space on the physical volumes. For information on this parameter, see the inline documentation for the/etc/lvm/lvm.conffile, which is also documented in 付録B LVM 設定ファイル.

2.1.4. Red Hat Enterprise Linux 6.3 で新規追加および変更された機能

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 6.3 では、ドキュメントと機能が以下のように更新/変更されています。

- As of the Red Hat Enterprise Linux 6.3 release, LVM supports RAID4/5/6 and a new implementation of mirroring. For information on RAID logical volumes, see 「RAID 論理ボリューム」.

- When you are creating a new mirror that does not need to be revived, you can specify the

--nosyncargument to indicate that an initial synchronization from the first device is not required. For information on creating mirrored volumes, see 「ミラー化ボリュームの作成」. - This manual now documents the snapshot

autoextendfeature. For information on creating snapshot volumes, see 「スナップショットボリュームの作成」.

2.1.5. Red Hat Enterprise Linux 6.4 で新規追加および変更された機能

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 6.4 では、ドキュメントと機能が以下のように更新/変更されています。

- 論理ボリュームのシンプロビジョニングが可能になりました。これにより、利用可能なエクステントより大きい論理ボリュームを作成できます。シンプロビジョニングを使用すると、空き領域のストレージプール (シンプールと呼ばれる) を管理して、アプリケーションにより必要な場合に任意の数のデバイスに割り当てることができます。その後、アプリケーションを実際に論理ボリュームに書き込むときに、シンプールにバインド可能なデバイスを後ほどの割り当て用に作成できます。シンプールは、コスト効率が高いストレージ領域の割り当てに必要な場合に動的に拡張できます。For general information on thinly-provisioned logical volumes, see 「シンプロビジョニングされた論理ボリューム (シンボリューム)」. For information on creating thin volumes, see 「シンプロビジョニングされた論理ボリュームの作成」.

- Red Hat Enterprise Linux 6.4 バージョンの LVM は、シンプロビジョニングされたスナップショットボリュームのサポートを提供します。シンプロビジョニングされたスナップショットボリュームにより、多くの仮想デバイスを同じデータボリューム上に格納することができます。これにより管理が簡略化され、スナップショットボリューム間でのデータシェアが可能になります。For general information on thinly-provisioned snapshot volumes, see 「シンプロビジョニングされたスナップショットボリューム」. For information on creating thin snapshot volumes, see 「シンプロビジョニングされたスナップショットボリュームの作成」.

- 本ガイドには、LVM の割り当てポリシーについて説明した 「LVM の割り当て」 のセクションが新たに追加されました。

- LVM now provides support for

raid10logical volumes. For information on RAID logical volumes, see 「RAID 論理ボリューム」. - Red Hat Enterprise Linux 6.4 リリースは、LVM メタデータデーモンである

lvmetadをサポートしています。このデーモンを有効にすることで、多くのブロックデバイスを持つシステムのスキャン量を減らすことができます。lvmetadデーモンは、クラスターのノード間では現在サポートされておらず、ロックタイプはローカルのファイルベースである必要があります。For information on the metadata daemon, see 「メタデータデーモン (lvmetad)」.

さらに、ドキュメント全体にわたり技術的な内容の若干の修正と明確化を行いました。

2.1.6. New and Changed Features for Red Hat Enterprise Linux 6.5

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 6.5 includes the following documentation and feature updates and changes.

- You can control I/O operations on a RAID1 logical volume with the

--writemostlyand--writebehindparameters of thelvchangecommand. For information on these parameters, see 「Controlling I/O Operations on a RAID1 Logical Volume」. - The

lvchangecommand now supports a--refreshparameter that allows you to restore a transiently failed device without having to reactivate the device. This feature is described in 「RAID の割り当てフォルトポリシー」. - LVM provides scrubbing support for RAID logical volumes. For information on this feature, see 「Scrubbing a RAID Logical Volume」.

- The fields that the

lvscommand supports have been updated. For information on thelvscommand, see 表5.4「lvs 表示フィールド」. - The

lvchangecommand supports the new--maxrecoveryrateand--minrecoveryrateparameters, which allow you to control the rate at whichsyncoperations are performed. For information on these parameters, see 「Scrubbing a RAID Logical Volume」. - You can control the rate at which a RAID logical volume is initialized by implementing recovery throttling. You control the rate at which

syncoperations are performed by setting the minimum and maximum I/O rate for those operations with the--minrecoveryrateand--maxrecoveryrateoptions of thelvcreatecommand, as described in 「RAID 論理ボリュームの作成」. - You can now create a thinly-provisioned snapshot of a non-thinly-provisioned logical volume. For information on creating these volumes, known as external volumes, see 「シンプロビジョニングされたスナップショットボリューム」.

さらに、ドキュメント全体にわたり技術的な内容の若干の修正と明確化を行いました。

2.1.7. New and Changed Features for Red Hat Enterprise Linux 6.6

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 6.6 includes the following documentation and feature updates and changes.

- The documentation for thinly-provisioned volumes and thinly-provisioned snapshots has been clarified. Additional information about LVM thin provisioning is now provided in the

lvmthin(7) man page. For general information on thinly-provisioned logical volumes, see 「シンプロビジョニングされた論理ボリューム (シンボリューム)」. For information on thinly-provisioned snapshot volumes, see 「シンプロビジョニングされたスナップショットボリューム」. - This manual now documents the

lvm dumpconfigcommand, in 「ThelvmconfigCommand」. Note that as of the Red Hat Enterprise Linux 6.8 release, this command was renamedlvmconf, although the old format continues to work. - This manual now documents LVM profiles, in 「LVM Profiles」.

- This manual now documents the

lvmcommand in 「Displaying LVM Information with thelvmCommand」. - In the Red Hat Enterprise Linux 6.6 release, you can control activation of thin pool snapshots with the -k and -K options of the

lvcreateandlvchangecommand, as documented in 「Controlling Logical Volume Activation」. - This manual documents the

--forceargument of thevgimportcommand. This allows you to import volume groups that are missing physical volumes and subsequently run thevgreduce --removemissingcommand. For information on thevgimportcommand, see 「ボリュームグループの別のシステムへの移動」.

さらに、ドキュメント全体にわたり技術的な内容の若干の修正と明確化を行いました。

2.1.8. New and Changed Features for Red Hat Enterprise Linux 6.7

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 6.7 includes the following documentation and feature updates and changes.

- As of Red Hat Enterprise Linux release 6.7, many LVM processing commands accept the

-Sor--selectoption to define selection criteria for those commands. LVM selection criteria are documented in the new appendix 付録C LVM Selection Criteria. - This document provides basic procedures for creating cache logical volumes in 「Creating LVM Cache Logical Volumes」.

- The troubleshooting chapter of this document includes a new section, 「Duplicate PV Warnings for Multipathed Devices」.

2.1.9. New and Changed Features for Red Hat Enterprise Linux 6.8

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 6.8 includes the following documentation and feature updates and changes.

- When defining selection criteria for LVM commands, you can now specify time values as selection criteria for fields with a field type of

time. For information on specifying time values as selection criteria, see 「Specifying Time Values」.

2.2. 論理ボリューム

リンクのコピーリンクがクリップボードにコピーされました!

ボリューム管理によって、物理ストレージ上に抽象化レイヤが作成され、論理ストレージボリュームを作成できるようになります。これは、物理ストレージディレクトリを使用するよりもはるかに高い柔軟性を数々の方法で提供します。論理ボリュームが作成されると、物理ディスクのサイズに制限されません。また、ハードウェアストレージ設定は、ソフトウェアには表示されないので、アプリケーションを停止したりファイルシステムをアンマウントせずに、サイズ変更や移動が可能になります。これにより運用コストを削減することができます。

論理ボリュームは、物理ストレージを直接使用するのと比べると、以下のような利点があります:

- 容量の柔軟性論理ボリュームを使用している場合、ディスクとパーティションを1つの論理ボリュームに集約できるため、ファイルシステムを複数のディスクに渡って拡張することが可能です。

- サイズ変更可能なストレージプール基になるディスクデバイスを再フォーマットしたり再パーティションせずに、簡単なソフトウェアコマンドを使用して論理ボリュームのサイズを拡大したり縮小したりすることができます。

- オンラインデータ移動より新しく、迅速で、障害耐性の高いストレージサブシステムを導入するために、システムがアクティブな時でもデータを移動することができます。データはディスクが使用中の場合でもディスク上で再配置できます。例えば、ホットスワップ可能なディスクを削除する前に空にすることができます。

- 便宜的なデバイスの命名論理ストレージボリュームはユーザー定義のグループで管理することができ、便宜的な命名をすることが可能です。

- ディスクのストライプ化2つまたはそれ以上のディスクに渡ってデータをストライプ化する論理ボリュームを作成することができます。これにより、スループットが劇的に向上します。

- ボリュームのミラー化論理ボリュームはデータのミラー化の設定に便利な手法を提供します。

- ボリュームスナップショット論理ボリュームを使用すると、一貫性のあるバックアップのためのデバイススナップショットを取ったり、実際のデータに影響を及ぼすことなく変更の効果をテストすることができます。

LVM でのこれらの機能の実装については、本ガイドの後半で説明しています。

2.3. LVM アーキテクチャーの概要

リンクのコピーリンクがクリップボードにコピーされました!

Linux オペレーティングシステムの Red Hat Enterprise Linux 4 リリースでは、オリジナルの LVM1 論理ボリュームマネージャが LVM2 に置き換えられました。LVM2 は、LVM1 よりも汎用性の高いカーネルフレームワークを採用しています。また、LVM2 は、LVM1 と比べて、以下のような点が改善されています:

- 容量の柔軟性

- より効率的なメタデータストレージ

- より優れた復元の形式

- 新たな ASCII メタデータ形式

- メタデータのアトミックな変更

- メタデータの冗長コピー

LVM2 は LVM1 に対して下位互換性を持っています。ただし、スナップショットとクラスターサポートは例外となっています。ボリュームグループは、

vgconvert コマンドを使用して LVM1 形式から LVM2 形式に変換することができます。LVM メタデータ形式の変換に関する情報は、vgconvert(8) の man ページをご覧ください。

LVM 論理ボリュームの配下の物理ストレージユニットは、パーティションあるいはディスク全体などのブロックデバイスです。このデバイスは LVM 物理ボリューム (Physical Volume: PV) として初期化されます。

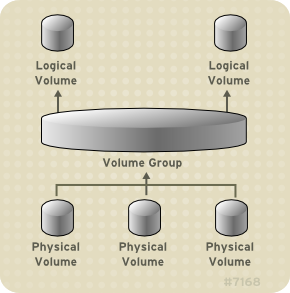

LVM 論理ボリュームを作成するために、物理ボリュームは ボリュームグループ (Volume Group: VG) に統合されます。これによってディスク領域のプールが作成され、そこから LVM 論理ボリューム (Logical Volume: LV) が割り当てられます。この工程は、ディスクがパーティションに分割される方法に類似しています。論理ボリュームはファイルシステムやアプリケーション (データベースなど) に使用されます。

図2.1「LVM 論理ボリュームのコンポーネント」 簡易 LVM 論理ボリュームのコンポーネントを示しています:

図2.1 LVM 論理ボリュームのコンポーネント

LVM 論理ボリュームのコンポーネントに関する詳細情報については、3章LVM コンポーネント をご覧ください。

2.4. クラスター化論理ボリュームマネージャ (CLVM)

リンクのコピーリンクがクリップボードにコピーされました!

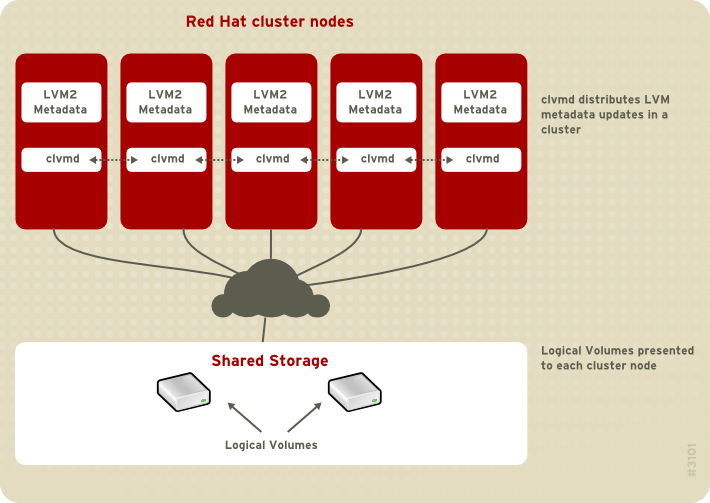

Clustered Logical Volume Manager (CLVM) は LVM のクラスタリング拡張機能セットです。これらの拡張機能により、コンピューターのクラスターは、LVM を使用した共有ストレージ (例: SAN 上のストレージ) を管理できるようになります。CLVM は、Resilient Storage アドオンの一部です。

CLVM を使用すべきかどうかはシステム要件により左右されます:

- ご使用のシステムのノードの1つのみが、論理ボリュームとして設定するストレージへのアクセスを必要とする場合は、CLVM 拡張機能を使用せずに LVM が使用可能であり、そのノードで作成される論理ボリュームは、そのノードに対してすべてローカルとなります。

- フェイルオーバーにクラスター化したシステムを使用しており、ストレージにアクセスする単一のノードのみが常にアクティブである場合は、High Availability Logical Volume Management (HA-LVM) エージェントの使用をお勧めします。

- ご使用のクラスターの複数のノードが共有ストレージへのアクセスを必要とし、そのストレージがアクティブなノード間で共有される場合は、CLVM を使用する必要があります。CLVM の使用により、ユーザーは論理ボリュームの設定中に物理ストレージへのアクセスをロックすることによって、共有ストレージ上の論理ボリュームを設定することができるようになります。CLVM は、クラスター化ロッキングサービスを使用して共有ストレージを管理します。

CLVM を使用するには、

clvmd デーモンを含む High Availability アドオンおよび Resilient Storage アドオンのソフトウェアが稼働していなければなりません。clvmd デーモンは LVM の主要なクラスタリング拡張機能です。clvmd デーモンは、各クラスターコンピューター内で稼働し、クラスター内で LVM メタデータ更新を配布して、各クラスターコンピューターに論理ボリュームの同一ビューを提供します。High Availability アドオンのインストールと管理の詳細については、『クラスターの管理』 を参照してください。

clmvd が起動時に確実に開始するようにするためには、以下のようにして、chkconfig ... on コマンドをclvmd サービスに対して実行します:

chkconfig clvmd on

# chkconfig clvmd onclvmd デーモンが開始していない場合は、以下のようにして、clvmd サービスを service ... start コマンドで実行します。

service clvmd start

# service clvmd start

クラスター環境で LVM 論理ボリュームを作成することは、単一ノード上に LVM 論理ボリュームを作成することと同じです。5章CLI コマンドでの LVM 管理 と 8章LVM GUI での LVM 管理 で示してあるように、LVM コマンド自体や LVM グラフィカルユーザーインターフェースに相違はありません。クラスター内に作成する LVM ボリュームを有効にするためには、クラスターインフラストラクチャーが稼働中で、かつクラスターが定足数を満たしている必要があります。

デフォルトでは、共有ストレージ上に CLVM で作成された論理ボリュームは、その共有ストレージにアクセス可能なすべてのシステムに対して可視となっています。ただし、全ストレージデバイスがクラスター内の 1 つのノードのみに可視となるようにボリュームグループを作成することも可能です。また、ボリュームグループのステータスをローカルボリュームグループからクラスター化ボリュームグループへ変更することもできます。詳細については、「クラスター内でのボリュームグループ作成」 および 「ボリュームグループのパラメーター変更」 をご覧ください。

警告

CLVM を使用して共有ストレージ上にボリュームグループを作成する際には、クラスター内のすべてのノードがボリュームグループを構成する物理ボリュームに確実にアクセスできるようにする必要があります。ストレージにアクセスできるノードとできないノードが混在する、非対称型のクラスター構成はサポートされていません。

図2.2「CLVM の概観」 は、クラスター内の CLVM の概観を示しています。

図2.2 CLVM の概観

注記

CLVM で、クラスター全体をロッキングするには、

lvm.conf ファイルを変更する必要があります。クラスター化ロッキングをサポートするための lvm.conf ファイルの設定に関する情報は、lvm.conf ファイル自体に記載されています。lvm.conf ファイルについての情報は 付録B LVM 設定ファイル をご覧ください。

2.5. ドキュメントの概要

リンクのコピーリンクがクリップボードにコピーされました!

本ガイドの後半には、以下のような章が含まれています:

- 3章LVM コンポーネント では、LVM 論理ボリュームを構成するコンポーネントについて説明しています。

- 4章LVM 管理の概要 では、LVM コマンドラインインターフェース (CLI) コマンドを使用するか、LVM グラフィカルユーザーインターフェース (GUI) を使用するかにかかわらず、LVM 論理ボリュームを設定するにあたって実行する基本手順の概要を提供します。

- 5章CLI コマンドでの LVM 管理 では、論理ボリュームの作成と保守を行うために LVM CLI コマンドで実行できる個別の管理タスクをまとめています。

- 6章LVM 設定の例 では、LVM の各種設定を示した例を記載しています。

- 7章LVM トラブルシューティング では、LVM の各種問題のトラブルシューティングの手順について説明します。

- 8章LVM GUI での LVM 管理 では、LVM GUI の操作についてまとめています。

- 付録A デバイスマッパー では、論理ボリュームと物理ボリュームをマップするために LVM が使用するデバイスマッパーについて説明します。

- 付録B LVM 設定ファイル では、LVM 設定ファイルについて説明します。

- 付録D LVM オブジェクトタグ では、LVM オブジェクトタグとホストタグについて説明します。

- 付録E LVM ボリュームグループメタデータ では、LVM ボリュームグループメタデータについて説明しており、LVM ボリュームグループ用のメタデータのサンプルコピーを含んでいます。

第3章 LVM コンポーネント

リンクのコピーリンクがクリップボードにコピーされました!

この章では、LVM 論理ボリュームのコンポーネントについて説明します。

3.1. 物理ボリューム

リンクのコピーリンクがクリップボードにコピーされました!

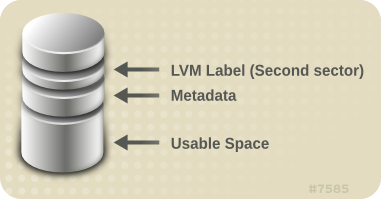

LVM 論理ボリュームの配下にある物理ストレージユニットは、パーティションやディスク全体のようなブロックデバイスです。LVM 論理ボリューム用にデバイスを使用するには、デバイスは物理ボリューム (PV) として初期化されなければなりません。ブロックデバイスを物理ボリュームとして初期化すると、デバイスの先頭位置にラベルを付けられます。

デフォルトでは、LVM ラベルは2番目の 512 バイトセクターに配置されます。先頭の4つのセクターのいずれかにラベルを配置することにより、このデフォルトを書き換えることができます。これにより、LVM ボリュームは、必要であればこれらのセクターの他のユーザーと共存できるようになります。

システム起動時にデバイスは任意の順序で立ち上がることがあります。そのため、LVM ラベルでは、物理デバイスに正しい ID とデバイスの順序を提供します。LVM ラベルは再起動後にもクラスター全域に渡って永続的な状態が維持されます。

LVM ラベルは、デバイスを LVM 物理ボリュームとして識別するものです。これは、物理ボリューム用のランダムな一意識別子 (UUID) を含んでいます。また、ブロックデバイスのサイズもバイト単位で保存し、LVM メタデータがデバイス上で保存される位置も記録します。

LVM メタデータには、システム上の LVM ボリュームグループの設定詳細が含まれています。デフォルトでは、メタデータの複製コピーが、ボリュームグループ内ですべての物理ボリュームのすべてのメタデータエリアで維持されています。LVM メタデータは小規模で ASCII 形式で格納されます。

現在、LVM により、各物理ボリューム上のメタデータの1つまたは2つの同一コピーの保存が可能になっています。デフォルトでは、コピーは1つです。物理ボリューム上のメタデータのコピー数を一旦設定すると、後でその数を変更することはできません。最初のコピーはデバイスの先頭のラベルの後に保存されます。2つ目のコピーがある場合は、それはデバイスの最終位置に配置されます。意図したものとは異なるディスクに書き込みをして、ディスクの先頭位置に誤って上書きしてしまった場合でも、デバイス後部にあるメタデータの2つ目のコピーでメタデータの復元が可能となります。

LVM メタデータとメタデータパラメーターの変更に関する詳細については、付録E LVM ボリュームグループメタデータ をご覧ください。

3.1.1. LVM 物理ボリュームレイアウト

リンクのコピーリンクがクリップボードにコピーされました!

図3.1「物理ボリュームレイアウト」 LVM 物理ボリュームのレイアウトを示しています。LVM ラベルは2番目のセクターにあり、その後にメタデータ領域とデバイスの使用可能なスペースが順に続いています。

注記

Linux カーネル (および本ガイド全体) では、セクターは 512 バイトのサイズとされています。

図3.1 物理ボリュームレイアウト

3.1.2. ディスク上の複数パーティション

リンクのコピーリンクがクリップボードにコピーされました!

LVM の使用により、ディスクパーティションから物理ボリュームを作成することが可能になります。それを以下のような理由により、ディスク全体をカバーする1つのパーティションを作成して、単一の LVM 物理ボリュームとしてラベルを付けることが一般的に推奨されます:

- 管理上の便宜それぞれの実ディスクが1度だけ提示されると、システム内のハードウェアを追跡記録するのが簡単になります。これはディスクに障害が発生した場合に、特に役に立ちます。更には、単一のディスク上の複数物理ボリュームは、起動時にカーネルによって不明なパーティションとして警告を受ける原因となる可能性があります。

- ストライピングのパフォーマンスLVM は、2 つの物理ボリュームが同一の物理ディスクにあることは認識しません。2 つの物理ボリュームが同一の物理ディスク上にある場合にストライプ化された論理ボリュームを作成すると、ストライプ化されたボリュームは同じディスク上の異なるパーティション上にある可能性があります。これはパフォーマンスの向上ではなく、低下をもたらします。

推奨されることではありませんが、1 つのディスクを別々の LVM 物理ボリュームに分割しなければならない状況が考えられます。例えば、少数のディスクしかないシステム上では、既存システムを LVM ボリュームに移行する場合にデータをパーティション間で移動しなければならない場合があります。さらに、大容量のディスクが存在し、管理目的で複数のボリュームグループを必要とする場合は、そのディスクでパーティションを設定する必要があります。ディスクに複数のパーティションがあり、それらのパーティションがいずれも同じボリュームグループ内に存在する場合にストライプ化ボリュームを作成する時には、論理ボリュームに含めるパーティションの指定は注意して行ってください。

3.2. ボリュームグループ

リンクのコピーリンクがクリップボードにコピーされました!

物理ボリュームはボリュームグループ (VG) に統合されます。これにより、論理ボリュームに割り当てるためのディスク領域のプールが作成されます。

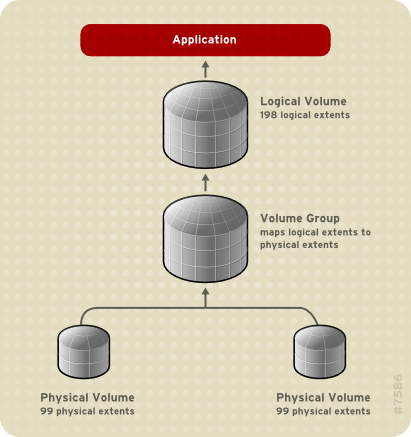

ボリュームグループ内で、割り当て可能なディスク領域はエクステントと呼ばれる固定サイズの単位に分割されます。1 エクステントが割り当て可能な領域の最小単位となります。物理ボリューム内では、エクステントは物理エクステントと呼ばれます。

論理ボリュームは物理エスクテントと同サイズの論理エクステント割り当てることができます。そのため、エクステントは、ボリュームグループ内のすべての論理ボリュームで同じサイズになります。ボリュームグループは論理エクステントを物理エクステントにマッピングします。

3.3. LVM 論理ボリューム

リンクのコピーリンクがクリップボードにコピーされました!

LVM では、ボリュームグループは複数のボリュームに分割されます。LVM 論理ボリュームには 3つのタイプがあります。リニア (linear) ボリューム、 ストライプ化 (striped) ボリューム、および ミラー化 (mirrored) ボリュームです。これらについては、以下のセクションで説明します。

3.3.1. リニアボリューム

リンクのコピーリンクがクリップボードにコピーされました!

リニアボリュームは複数の物理ボリュームの領域を 1 つの論理ボリュームに統合します。例えば、60GB ディスクが 2 つある場合、120GB の論理ボリュームを作成できます。物理ストレージは連結されます。

リニアボリュームを作成すると、物理エクステントの範囲を順番に論理ボリュームの領域に割り当てることになります。例えば、図3.2「エクステントマッピング」 に示してあるように、1から 99 までの論理エクステントを1つの物理ボリュームにマッピングして、 100 から 198 までの論理エクステントを2番目の物理ボリュームにマッピングすることができます。アプリケーションの観点からは、デバイスには 198 のエクステントのサイズのデバイスが1つあることになります。

図3.2 エクステントマッピング

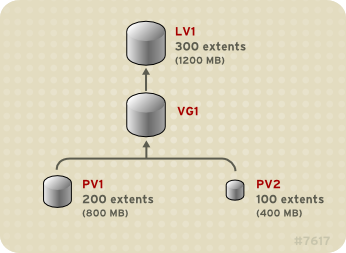

The physical volumes that make up a logical volume do not have to be the same size. 図3.3「サイズの異なる物理ボリュームを用いたリニアボリューム」 shows volume group

VG1 with a physical extent size of 4MB. This volume group includes 2 physical volumes named PV1 and PV2. The physical volumes are divided into 4MB units, since that is the extent size. In this example, PV1 is 200 extents in size (800MB) and PV2 is 100 extents in size (400MB). You can create a linear volume any size between 1 and 300 extents (4MB to 1200MB). In this example, the linear volume named LV1 is 300 extents in size.

図3.3 サイズの異なる物理ボリュームを用いたリニアボリューム

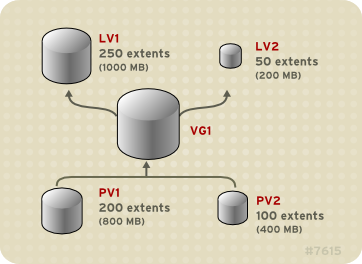

物理エクステントのプールから希望のサイズのリニア論理ボリュームを複数設定することができます。図3.4「複数の論理ボリューム」 は、図3.3「サイズの異なる物理ボリュームを用いたリニアボリューム」 と同じボリュームグループを示していますが、この場合は、そのボリュームグループから 2 つの論理ボリュームが作り出されています。

LV1 は 250 エクステントでサイズは 1000MB です。LV2 は 50 エクステントでサイズは 200MB です。

図3.4 複数の論理ボリューム

3.3.2. ストライプ化論理ボリューム

リンクのコピーリンクがクリップボードにコピーされました!

LVM 論理ボリューム上にデータを書き込む場合、ファイルシステムは、配下にある物理ボリュームすべてに渡ってデータを分配します。その場合、ストライプ化論理ボリュームを作成することにより、データを物理ボリュームに書き込む方法を制御することができます。大量の順次読み取りと書き込みには、この方法でデータ I/O の効率を向上させることが可能です。

ストライピングは、所定数の物理ボリュームにデータをラウンドロビン式に書き込んでいくことにより、パフォーマンスを向上させます。ストライピングでは、I/O は並行して実行されます。場合によっては、これはストライプ内に追加する各物理ボリュームに、ほぼ直線的なパフォーマンス向上をもたらします。

以下のイラストでは、3つの物理ボリュームに渡ってデータがストライプ化されている状態を示しています。この図では:

- データの1番目のストライプは PV1 に書き込まれます。

- データの2番目のストライプは PV2 に書き込まれます。

- データの3番目のストライプは PV3 に書き込まれます。

- データの4番目のストライプは PV1 に書き込まれます。

ストライプ化された論理ボリュームでは、ストライプのサイズはエクステントのサイズを超過することはできません。

図3.5 3つの PV に渡るストライプのデータ

Striped logical volumes can be extended by concatenating another set of devices onto the end of the first set. In order to extend a striped logical volume, however, there must be enough free space on the underlying physical volumes that make up the volume group to support the stripe. For example, if you have a two-way stripe that uses up an entire volume group, adding a single physical volume to the volume group will not enable you to extend the stripe. Instead, you must add at least two physical volumes to the volume group. For more information on extending a striped volume, see 「ストライプ化ボリュームの拡張」.

3.3.3. ミラー化論理ボリューム

リンクのコピーリンクがクリップボードにコピーされました!

ミラーはデータの同一コピーを異なるデバイスに維持します。データが1つのデバイスに書き込まれると、それはまた2つ目のデバイスにも書き込まれて、データのミラー化をします。この重複保存により、デバイス障害に対する保護を提供します。ミラーレッグの1つに障害が発生した場合、論理ボリュームはリニアボリュームとなりますが、依然としてアクセス可能です。

LVM はミラー化ボリュームに対応しています。ミラー化論理ボリュームを作成する場合、LVM は、配下にある物理ボリュームに書き込まれるデータが、別の物理ボリュームに確実にミラー化されるようにします。LVM では、複数のミラーを持つミラー化論理ボリュームを作成することができます。

LVM ミラーは複製されるデバイスを、標準的な 512KB サイズのリージョンに分割します。LVM はミラーと同期しているリージョンを追跡記録するのに使用する小さなログを維持します。このログは、再起動後にも永続的に残るようにディスク上に保存したり、メモリー内で維持したりすることができます。

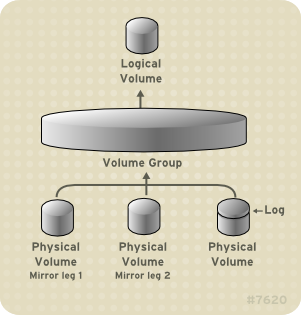

図3.6「ミラー化論理ボリューム」 は、単一のミラーを用いたミラー化論理ボリュームを示しています。この設定では、ログはディスク上で維持されます。

図3.6 ミラー化論理ボリューム

ミラーの作成と修正に関する情報は、 「ミラー化ボリュームの作成」 をご覧ください。

3.3.4. RAID Logical Volumes

リンクのコピーリンクがクリップボードにコピーされました!

As of the Red Hat Enterprise Linux 6.3 release, LVM supports RAID logical volumes. For information on the RAID implementations that LVM supports, see 「RAID 論理ボリューム」.

3.3.5. シンプロビジョニングされた論理ボリューム (シンボリューム)

リンクのコピーリンクがクリップボードにコピーされました!

As of the Red Hat Enterprise Linux 6.4 release, logical volumes can be thinly provisioned. This allows you to create logical volumes that are larger than the available extents. Using thin provisioning, you can manage a storage pool of free space, known as a thin pool, which can be allocated to an arbitrary number of devices when needed by applications. You can then create devices that can be bound to the thin pool for later allocation when an application actually writes to the logical volume. The thin pool can be expanded dynamically when needed for cost-effective allocation of storage space.

注記

シンボリュームはクラスターのノード間ではサポートされません。シンプールとそのすべてのシンボリュームは、1 つのクラスターノードでのみ排他的にアクティブ化する必要があります。

ストレージ管理者は、シンプロビジョニングを使用することで物理ストレージをオーバーコミットできるため、多くの場合、追加のストレージを購入する必要がなくなります。例えば、10 人のユーザーが各アプリケーション用にそれぞれ 100GB ファイルシステムを要求した場合、ストレージ管理者は各ユーザーに 100GB ファイルシステムと思われるもの (しかし実際は 100GB より少ないストレージにより利用可能で必要な場合にのみ使用される) を作成できます。シンプロビジョニングの使用時には、ストレージ管理者は、ストレージプールをモニターして、容量が一杯になり始めたら容量を追加することが重要です。

すべての利用可能な領域が使用できるようにするために、LVM ではデータの破棄が可能です。これにより、破棄されたファイルやその他のブロックの範囲で以前に使用された領域を再利用できます。

For information on creating thin volumes, see 「シンプロビジョニングされた論理ボリュームの作成」.

Thin volumes provide support for a new implementation of copy-on-write (COW) snapshot logical volumes, which allow many virtual devices to share the same data in the thin pool. For information on thin snapshot volumes, see 「シンプロビジョニングされたスナップショットボリューム」.

3.3.6. スナップショットボリューム

リンクのコピーリンクがクリップボードにコピーされました!

LVM スナップショット機能により、サービスを中断せずに任意の時点でデバイスの仮想イメージを作成することができます。スナップショットの取得後に複製元のデバイスに変更が加えられた場合、このスナップショット機能により、データが変更される前に変更部分のコピーを作成してデバイスの状態を再構築できます。

注記

As of the Red Hat Enterprise Linux 6.4 release, LVM supports thinly-provisioned snapshots. For information on thinly provisioned snapshot volumes, see 「シンプロビジョニングされたスナップショットボリューム」.

注記

LVM スナップショットは、クラスター内のノード全域に渡ってはサポートされていません。クラスター化されたボリュームグループ内ではスナップショットボリュームを作成できません。

スナップショットは、スナップショットが作成された後に変更されたデータ部分のみをコピーするため、スナップショット機能に必要なストレージの容量は最小限で済みます。例えば、複製元が稀にしか更新されない場合、その容量の 3-5 % だけで十分にスナップショットを維持することができます。

注記

ファイルシステムのスナップショットコピーは仮想コピーであり、ファイルシステム用の実際のメディアバックアップではありません。スナップショットはバックアップ手順の代替を提供するものではありません。

スナップショットのサイズによって、複製元のボリュームへの変更を保管するために確保するスペースの量が左右されます。例えば、スナップショットを作成後に複製元を完全に上書きした場合に、その変更を保管するには、スナップショットが最低でも複製元のボリュームと同じサイズである必要があることになります。スナップショットのサイズは、予想される変更レベルに応じて決定する必要があります。例えば、

/usr などの、ほとんど読み取り用に使用されるボリュームの短期的なスナップショットには、/home のように大量の書き込みが行われるボリュームの長期的なスナップショットほどスペースを必要としません。

スナップショットが満杯になると、スナップショットは無効になります。これは、複製元のボリューム上の変更をトラッキングできなくなるためです。スナップショットのサイズは常時監視する必要があります。ただし、スナップショットは完全にサイズ変更可能のため、ストレージに余裕があれば、スナップショットのボリュームサイズを拡大してそれが停止することを防止できます。逆に、スナップショットボリュームサイズが必要以上に大きければ、そのボリュームのサイズを縮小して、他の論理ボリューム用に必要となる領域を開放することができます。

スナップショットファイルシステムを作成すると、複製元への完全な読み取り/書き込みのアクセスがそのまま残ります。スナップショット上のチャンクが変更された場合、そのチャンクはマーク付けされ、そこには複製元のボリュームのコピーは入りません。

スナップショット機能にはいくつかの用途があります:

- 最も一般的な用途は、継続的にデータを更新している稼動中のシステムを停止せずに、論理ボリューム上でバックアップを実行する必要がある場合のスナップショット作成です。

- スナップショットファイルシステム上で

fsckコマンドを実行すると、ファイルシステムの整合性をチェックして、複製元のファイルシステムが修復を必要とするかどうかを判断することができます。 - スナップショットは読み取り/書き込み用のため、スナップショットを取ってそのスナップショットに対してテストを実行することにより、実際のデータに触れることなく実稼働データに対するアプリケーションのテストができます。

- LVM ボリュームを作成して、Red Hat の仮想化と併用することが可能です。LVM スナップショットを使用して、仮想ゲストイメージのスナップショットを作成することができます。これらのスナップショットは、最小限のストレージを使用して、既存のゲストの変更や新規ゲストの作成を行う利便性の高い方法を提供します。Red Hat の仮想化による LVM ベースのストレージプールの作成についての詳細は、『仮想化管理ガイド』 を参照してください。

スナップショットボリュームの作成に関する情報は、「ミラー化ボリュームの作成」 をご覧ください。

Red Hat Enterprise Linux 6 リリースでは、

lvconvert の --merge オプションを使用して、スナップショットを複製元のボリュームにマージすることが可能です。この機能の用途の1つとしてあげられるのは、データやファイルを紛失した際のシステムロールバックの実行で、これがなければ、以前の状態に復元する必要があります。スナップショットボリュームのマージの結果作成される論理ボリュームには複製元のボリューム名、マイナー番号、UUID が使用され、マージされたスナップショットは削除されます。このオプションの使用方法についての情報は、 「スナップショットボリュームのマージ」 をご覧ください。

3.3.7. シンプロビジョニングされたスナップショットボリューム

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 6.4 バージョンの LVM は、シンプロビジョニングされたスナップショットボリュームのサポートを提供します。シンプロビジョニングされたスナップショットボリュームにより、多くの仮想デバイスを同じデータボリューム上に格納することができます。これにより管理が簡略化され、スナップショットボリューム間でのデータシェアが可能になります。

すべてのシンボリュームだけでなくすべての LVM スナップショットボリュームの場合、シンプロビジョニングされたスナップショットボリュームはクラスター内のノード間でサポートされていません。スナップショットボリュームは、1 つのクラスターノードでのみ排他的にアクティブ化する必要があります。

シンプロビジョニングされたスナップショットボリュームの利点は以下のとおりです。

- 同じボリュームからのスナップショットが複数ある場合、シンプロビジョニングされたスナップショットボリュームはディスクの使用量を減らすことができます。

- 複製元が同じスナップショットが複数ある場合は、複製元に 1 回書き込むことにより 1 回の COW 操作でデータを保存できます。複製元のスナップショットの数を増やしても、大幅な速度の低下は発生しないはずです。

- シンプロビジョニングされたスナップショットボリュームは、別のスナップショットの作成元の論理ボリュームとして使用できます。これにより、再帰的スナップショット (スナップショットのスナップショットのそのまたスナップショットなど) の深度を任意に決定できます。

- シン論理ボリュームのスナップショットは、シン論理ボリュームを作成することもできます。これにより、COW 操作が必要になるまで、あるいはスナップショット自体が書き込まれるまで、データ領域は消費されません。

- シンプロビジョニングされたスナップショットボリュームは、その複製元によりアクティブ化する必要はありません。そのため、アクティブでないスナップショットボリュームが多くある間は、ユーザーは複製元のみをアクティブにしておくことができます。

- シンプロビジョニングされたスナップショットボリュームの複製元を削除する場合、複製元のボリュームの各スナップショットは、独立するシンプロビジョニングされたボリュームになります。これは、あるスナップショットとその複製元のボリュームをマージする代わりに、複製元のボリュームを削除して、その独立したボリュームを新しいスナップショットの複製元のボリュームとして使用して新しいシンプロビジョニングされたスナップショットを作成することが選択できることを意味しています。

シンプロビジョニングされたスナップショットボリュームを使用する利点は数多くありますが、旧の LVM スナップショットボリューム機能の方がご使用のニーズに合うケースがあります。

- シンプールのチャンクサイズは変更できません。シンプールのチャンクサイズが大きい場合 (1MB など) やチャンクサイズが短時間のスナップショットには効率的でない場合は、旧のスナップショット機能の使用を選択することができます。

- シンプロビジョニングされたスナップショットボリュームのサイズを制限することはできません。スナップショットは、必要な場合はシンプール内の全領域を使用するため、ご使用のニーズに合わない場合があります。

一般的には、使用するスナップショットの形式を決定する際に使用しているサイトの特定の要件を考慮に入れるようにしてください。

For information on configuring thin snapshot volumes, see 「シンプロビジョニングされたスナップショットボリュームの作成」.

3.3.8. Cache Volumes

リンクのコピーリンクがクリップボードにコピーされました!

As of the Red Hat Enterprise Linux 6.7 release, LVM supports the use of fast block devices (such as SSD drives) as write-back or write-though caches for larger slower block devices. Users can create cache logical volumes to improve the performance of their existing logical volumes or create new cache logical volumes composed of a small and fast device coupled with a large and slow device.

For information on creating LVM cache volumes, see 「Creating LVM Cache Logical Volumes」.

第4章 LVM 管理の概要

リンクのコピーリンクがクリップボードにコピーされました!

この章では、LVM 論理ボリュームの設定に用いる管理手続きの概要を説明し、必要な手順についての全般的な理解を図ることを目的としています。一般的な LVM 設定手順における特定の段階的な例については、6章LVM 設定の例 をご覧ください。

LVM 管理を執行するために使用できる CLI コマンドの説明については、5章CLI コマンドでの LVM 管理 を ご覧ください。別の方法として、8章LVM GUI での LVM 管理 で説明している LVM GUI を使用することもできます。

4.1. クラスター内での LVM ボリューム作成

リンクのコピーリンクがクリップボードにコピーされました!

クラスター環境内で論理ボリュームを作成するには、CLVM (Clustered Logical Volume Manager) を使用します。これは LVM へのクラスタリング拡張のセットです。この拡張により、コンピューターのクラスターが LVM を使用して共有ストレージ (例えば SAN 上など) を管理できるようになります。CLVM を使用するには、「クラスター化論理ボリュームマネージャ (CLVM)」 で示してあるように

clmvd デーモンを含む High Availability アドオンおよび Resilient Storage アオドンソフトウェアが、起動時に開始する必要があります。

クラスター環境で LVM 論理ボリュームを作成することは、単一ノード上に LVM 論理ボリュームを作成することと同じです。LVM コマンド自体や LVM GUI インターフェースに相違はありません。クラスター内に作成する LVM ボリュームを有効にするためには、クラスターインフラストラクチャーが稼働中で、かつクラスターが定足数を満たしている必要があります。

CLVM で、クラスター全体をロッキングするには、

lvm.conf ファイルを変更する必要があります。クラスター化ロッキングをサポートするための lvm.conf ファイルの設定に関する情報は、lvm.conf ファイル自体に記載されています。lvm.conf ファイルについての情報は 付録B LVM 設定ファイル をご覧ください。

デフォルトでは、共有ストレージ上に CLVM で作成された論理ボリュームは、その共有ストレージにアクセス可能なすべてのシステムに対して可視となっています。ただし、全ストレージデバイスがクラスター内の 1 つのノードのみに可視となるようにボリュームグループを作成することも可能です。また、ボリュームグループのステータスをローカルボリュームグループからクラスター化ボリュームグループへ変更することもできます。詳細については、「クラスター内でのボリュームグループ作成」 および 「ボリュームグループのパラメーター変更」 をご覧ください。

警告

CLVM を使用して共有ストレージ上にボリュームグループを作成する際には、クラスター内のすべてのノードがボリュームグループを構成する物理ボリュームに確実にアクセスできるようにする必要があります。ストレージにアクセスできるノードとできないノードが混在する、非対称型のクラスター構成はサポートされていません。

High Availability アドオンのインストールとクラスターインフラストラクチャーのセットアップ方法についての情報は、『クラスターの管理』 をご覧ください。

クラスター内でミラー化された論理ボリュームを作成する例は、「クラスター内でのミラー化 LVM 論理ボリュームの作成」 をご覧ください。

4.2. 論理ボリューム作成の概要

リンクのコピーリンクがクリップボードにコピーされました!

LVM 論理ボリュームを作成するために実行すべき手順を簡単にまとめると以下のようになります。

- LVM ボリューム用に使用するパーティションを物理ボリュームとして初期化します (この操作によってラベル付けされます)。

- ボリュームグループを作成します。

- 論理ボリュームを作成します。

論理ボリュームを作成した後は、ファイルシステムを作成してマウントできます。この文書内の例では、GFS2 ファイルシステムを使用します。

注記

GFS2 ファイルシステムはスタンドアロンシステムもしくはクラスター構成の一部として実装することが可能ですが、Red Hat Enterprise Linux 6 リリースでは、Red Hat は単一ノードのファイルシステムとしての GFS2 の使用をサポートしていません。クラスターファイルシステムのスナップショット (例: バックアップ目的) をマウントするための単一ノードの GFS2 ファイルシステムは引き続きサポートします。

mkfs.gfs2コマンドを使用して、論理ボリューム上に GFS2 ファイルシステムを作成します。mkdirコマンドで新規のマウントポイントを作成します。クラスター化システムでは、そのクラスター内のすべてのノード上にマウントポイントを作成します。- ファイルシステムをマウントします。システム内の各ノード用の

fstabに一行追加することもできます。

別の方法として、LVM GUI を使用して GFS2 ファイルシステムを作成してマウントすることもできます。

LVM セットアップ情報の保存エリアは物理ボリューム上にあって、ボリュームが作成されたマシンではないため、LVM ボリュームの作成はマシンから独立しています。ストレージを使用するサーバーがローカルコピーを持っていますが、それは物理ボリューム上にあるものから復元できます。LVM のバージョンが互換性を持つ場合には、物理ボリュームを異なるサーバーに接続することができます。

4.3. 論理ボリューム上におけるファイルシステムの拡張

リンクのコピーリンクがクリップボードにコピーされました!

論理ボリューム上でファイルシステムを拡張するには、以下の手順を実行します:

- 新規の物理ボリュームを作成します。

- 拡張するファイルシステムを持つ論理ボリュームを含んだボリュームグループを拡張して、新規の物理ボリュームを組み入れます。

- 論理ボリュームを拡張して新規の物理ボリュームを組み入れます。

- ファイルシステムを拡張します。

ボリュームグループ内に十分な未割り当ての領域がある場合は、手順1と2を実行する代わりに、その領域を使用して論理ボリュームを拡張することができます。

4.4. 論理ボリュームのバックアップ

リンクのコピーリンクがクリップボードにコピーされました!

メタデータのバックアップとアーカイブは、

lvm.conf ファイル内で無効になっていない限り、すべてのボリュームグループと論理ボリューム設定の変更時に自動的に作成されます。デフォルトでは、メタデータのバックアップは /etc/lvm/backup ファイルに保存され、メタデータのアーカイブは /etc/lvm/archive ファイルに保存されます。メタデータのアーカイブが /etc/lvm/archive ファイルに保存される期間と保存されるアーカイブファイルの数は、lvm.conf ファイル内で設定可能なパラメーターにより決定されます。日次のシステムバックアップでは、バックアップに /etc/lvm ディレクトリの内容が含まれる必要があります。

メタデータバックアップでは、論理ボリュームに含まれているユーザーとシステムのデータはバックアップされない点に注意してください。

vgcfgbackup コマンドを使用すると、/etc/lvm/backup ファイルにメタデータを手動でバックアップできます。また、vgcfgrestore コマンドを使用すると、メタデータを復元できます。vgcfgbackup コマンドと vgcfgrestore コマンドに ついては 「ボリュームグループメタデータのバックアップ」 で説明しています。

4.5. ロギング

リンクのコピーリンクがクリップボードにコピーされました!

すべてのメッセージ出力は、以下のロギングレベル用に独立した選択を持つロギングモジュールを通過します。

- 標準出力/エラー

- syslog

- ログファイル

- 外部ログ関数

ロギングのレベルは

/etc/lvm/lvm.conf ファイル内にセットされており、これに関しては、付録B LVM 設定ファイル で説明があります。

4.6. メタデータデーモン (lvmetad)

リンクのコピーリンクがクリップボードにコピーされました!

LVM はオプションで中央メタデータキャッシュを使用できます。これはデーモン (

lvmetad) と udev ルールにより実装されます。このメタデータデーモンの目的は主に 2 つあります。1 つ目は LVM コマンドのパフォーマンスを向上すること、2 つ目はシステムが論理ボリュームまたはボリュームグループ全体を利用できるようになった時に udev がそれらを自動的にアクティブ化できることです。

注記

lvmetad デーモンは、クラスターのノード間では現在サポートされておらず、ロックタイプはローカルのファイルベースである必要があります。

このデーモンの利点を活用するには、以下を実行してください。

lvm2-lvmetadサービスを使ってデーモンを起動します。デーモンをブート時に自動起動するには、chkconfig lvm2-lvmetad onコマンドを使用してください。手動でデーモンを起動するには、service lvm2-lvmetad startコマンドを使用してください。- Configure LVM to make use of the daemon by setting the

global/use_lvmetadvariable to 1 in thelvm.confconfiguration file. For information on thelvm.confconfiguration file, see 付録B LVM 設定ファイル.

Normally, each LVM command issues a disk scan to find all relevant physical volumes and to read volume group metadata. However, if the metadata daemon is running and enabled, this expensive scan can be skipped. Instead, the

lvmetad daemon scans each device only once, when it becomes available, by means of udev rules. This can save a significant amount of I/O and reduce the time required to complete LVM operations, particularly on systems with many disks. For information on the udev device manager and udev rules, see 「デバイスマッパーの udev デバイスマネージャサポート」.

When a new volume group is made available at runtime (for example, through hotplug or iSCSI), its logical volumes must be activated in order to be used. When the

lvmetad daemon is enabled, the activation/auto_activation_volume_list option in the lvm.conf configuration file can be used to configure a list of volume groups and logical volumes that should be automatically activated. Without the lvmetad daemon, a manual activation is necessary. By default, this list is not defined, which means that all volumes are autoactivated once all of the physical volumes are in place. The autoactivation works recursively for LVM stacked on top of other devices, as it is event-based.

注記

When the

lvmetad daemon is running, the filter = setting in the /etc/lvm/lvm.conf file does not apply when you execute the pvscan --cache device command. To filter devices, you need to use the global_filter = setting. Devices that fail the global filter are not opened by LVM and are never scanned. You may need to use a global filter, for example, when you use LVM devices in VMs and you do not want the contents of the devices in the VMs to be scanned by the physical host.

4.7. Displaying LVM Information with the lvm Command

リンクのコピーリンクがクリップボードにコピーされました!

The

lvm command provides several built-in options that you can use to display information about LVM support and configuration.

lvm devtypesDisplays the recognized built-in block device types (Red Hat Enterprise Linux release 6.6 and later).lvm formatsDisplays recognizes metadata formats.lvm helpDisplays LVM help text.lvm segtypesDisplays recognized logical volume segment types.lvm tagsDisplays any tags defined on this host. For information on LVM object tags, see 付録D LVM オブジェクトタグ.lvm versionDisplays the current version information.

第5章 CLI コマンドでの LVM 管理

リンクのコピーリンクがクリップボードにコピーされました!

この章では、論理ボリュームを作成し、保守するために LVM CLI (Command Line Interface) コマンドで実行できる個別の管理タスクについてまとめています。

注記

クラスター化環境用に LVM ボリュームを作成または変更する場合、

clvmd デーモンが稼働していることを確認する必要があります。詳細は 「クラスター内での LVM ボリューム作成」 を参照してください。

5.1. CLI コマンドの使用

リンクのコピーリンクがクリップボードにコピーされました!

すべての LVM CLI コマンドには一般的な特性がいくつかあります。

コマンドライン引数でサイズが必要な場合は、単位を常に明示的に指定することができます。単位を指定しないと、デフォルト (通常 KB か MB) が使用されます。LVM CLI コマンドでは小数は使用できません。

コマンドライン引数内で単位を指定する場合、LVM は大文字/小文字を区別せず (例えば、M か m の指定は同じことです)、2 の累乗 (1024 の倍数) が使用されます。しかし、コマンド内で

--units 引数を指定する場合、小文字では単位が 1024 の倍数、大文字では 1000 の倍数であることを示します。

コマンドが、ボリュームグループ名または論理ボリューム名を引数として取る場合、完全なパス名はオプションとなります。ボリュームグループ

vg0 内の論理ボリューム lvol0 は vg0/lvol0 と指定できます。ボリュームグループの一覧が必要であるのに空のままの場合、すべてのボリュームグループの一覧が代用されます。論理ボリュームの一覧が必要な状態で、1つのボリュームグループだけ提示されている場合、そのボリュームグループ内のすべての論理ボリュームの一覧が代用されます。例えば、lvdisplay vg0 コマンドは、ボリュームグループ vg0 内の すべての論理ボリュームを表示します。

すべての LVM コマンドは

-v 引数を使用できるため、これを複数回入力して出力の詳細度を高くすることができます。例えば、次の例では lvcreate コマンドのデフォルト出力を示しています。

lvcreate -L 50MB new_vg Rounding up size to full physical extent 52.00 MB Logical volume "lvol0" created

# lvcreate -L 50MB new_vg

Rounding up size to full physical extent 52.00 MB

Logical volume "lvol0" created

以下の例は、

-v 引数を使用した lvcreate コマンドの出力を示しています。

また、

-vv、-vvv、あるいは -vvvv の引数を使用して、コマンドの実行内容を徐々に詳しく表示することができます。-vvvv 引数は、現時点で最も詳細な情報を提供します。以下の例では、-vvvv 引数が指定された lvcreate コマンドの出力のうち最初の数行のみを示しています。

LVM CLI コマンドのいずれにも

--help 引数を付けると、そのコマンドのヘルプを表示することができます。

commandname --help

# commandname --help

コマンドの man ページを表示するには、

man コマンドを実行します。

man commandname

# man commandnameman lvm コマンドは、LVM に関する一般的なオンライン情報を提供します。

すべての LVM オブジェクトは、オブジェクトを作成した時に割り当てられる UUID によって、内部で参照されます。これは、例えばボリュームグループの一部である物理ボリューム

/dev/sdf を削除した後で、接続し直した際に、/dev/sdk となっていることが判明した場合などに役立ちます。LVM は物理ボリュームをそのデバイス名ではなく、UUID で識別するため、物理ボリュームを見つけることができます。物理ボリュームの作成時に物理ボリュームの UUID を指定する方法については、「物理ボリュームメタデータの復元」 をご覧ください。

5.2. 物理ボリュームの管理

リンクのコピーリンクがクリップボードにコピーされました!

このセクションでは、物理ボリューム管理の様々な側面を実行するコマンドを説明しています。

5.2.1. 物理ボリュームの作成

リンクのコピーリンクがクリップボードにコピーされました!

以下のサブセクションは、物理ボリューム作成に使用するコマンドを説明しています。

5.2.1.1. パーティションタイプの設定

リンクのコピーリンクがクリップボードにコピーされました!

物理ボリューム用にディスクデバイス全体を使用している場合、そのディスクにパーティションテーブルがあってはなりません。DOS のディスクパーティションの場合は、

fdisk または cfdisk もしくはそれらに相当するコマンドを使用して、パーティション ID が 0x8e にセットされている必要があります。ディスクデバイス全体のみの場合は、パーティションテーブルを消去する必要があり、これによって、そのディスク上の全データが実質的に破棄されます。以下のコマンドを使用して、最初のセクターをゼロで初期化すると既存のパーティションテーブルを削除することができます:

dd if=/dev/zero of=PhysicalVolume bs=512 count=1

# dd if=/dev/zero of=PhysicalVolume bs=512 count=15.2.1.2. 物理ボリュームの初期化

リンクのコピーリンクがクリップボードにコピーされました!

pvcreate コマンドを使用して、物理ボリュームとして使用するブロックデバイスを初期化します。初期化は、ファイルシステムのフォーマッティングと同様です。

以下のコマンドは、

/dev/sdd、/dev/sde、および /dev/sdf を LVM 物理ボリュームとして初期化します。これは LVM 論理ボリュームの一部として後ほど使用するためです。

pvcreate /dev/sdd /dev/sde /dev/sdf

# pvcreate /dev/sdd /dev/sde /dev/sdf

ディスク全体でなく、パーティションを初期化するには、そのパーティション上で

pvcreate コマンドを実行します。以下の例では、パーティション /dev/hdb1 を LVM 論理ボリュームの一部として後で使用するために、LVM 物理ボリュームとして初期化します。

pvcreate /dev/hdb1

# pvcreate /dev/hdb15.2.1.3. ブロックデバイスのスキャン

リンクのコピーリンクがクリップボードにコピーされました!

以下の例に示してあるように、

lvmdiskscan コマンドを使用して 物理ボリュームとして使用可能なブロックデバイスをスキャンできます。

5.2.2. 物理ボリュームの表示

リンクのコピーリンクがクリップボードにコピーされました!

LVM 物理ボリュームのプロパティを表示するのに使用できるコマンドは 3 つあります。

pvs、 pvdisplay、および pvscan です。

pvs コマンドは、物理ボリューム情報を設定可能な形式で提供して、1 つの物理ボリュームにつき 1 行ずつ表示します。pvs コマンドは豊富な書式制御を提供するため、スクリプティングに役立ちます。出力をカスタマイズするための pvs コマンドの使用に関する情報は 「LVM 用のカスタム報告」 をご覧ください。

The

pvdisplay command provides a verbose multi-line output for each physical volume. It displays physical properties (size, extents, volume group, and so on) in a fixed format.

以下の例では、単一物理ボリュームの

pvdisplay コマンドの出力を示しています。

pvscan コマンドは、物理ボリューム用にシステム内のサポートされたすべての LVM ブロックデバイスをスキャンします。

以下のコマンドは、検出された物理デバイスをすべて表示します。

You can define a filter in the

/etc/lvm/lvm.conf file so that this command will avoid scanning specific physical volumes. For information on using filters to control which devices are scanned, see 「フィルターを使用した LVM デバイススキャンの制御」.

5.2.3. 物理ボリューム上での割り当て防止

リンクのコピーリンクがクリップボードにコピーされました!

pvchange コマンドを使用すると、単一または複数の物理ボリュームの空き領域上での物理エクステントの割り当てを防止することができます。これは、ディスクエラーが発生した場合や、物理ボリュームを取り除く場合に必要となる可能性があります。

以下のコマンドは、

/dev/sdk1 上での物理エクステントの割り当てを無効にします。

pvchange -x n /dev/sdk1

# pvchange -x n /dev/sdk1pvchange コマンドで -xy 引数を使用すると、以前に無効にされていた割り当てを許可することができます。

5.2.4. 物理ボリュームのサイズ変更

リンクのコピーリンクがクリップボードにコピーされました!

なんらかの理由で配下のブロックデバイスのサイズを変更する必要がある場合は、

pvresize コマンドを使用して LVM を新規サイズに更新します。このコマンドは LVM が物理ボリュームを使用している間に実行することができます。

5.2.5. 物理ボリュームの削除

リンクのコピーリンクがクリップボードにコピーされました!

デバイスを LVM で使用する必要がなくなった場合、

pvremove コマンドを使用して LVM ラベルを削除することができます。pvremove コマンドを実行すると、空の物理ボリューム上の LVM メタデータをゼロにします。

削除したい物理ボリュームが現在ボリュームグループの一部である場合、「ボリュームグループからの物理ボリュームの削除」 で説明してあるように、

vgreduce コマンドでボリュームグループから物理ボリュームを取り除く必要があります。

pvremove /dev/ram15 Labels on physical volume "/dev/ram15" successfully wiped

# pvremove /dev/ram15

Labels on physical volume "/dev/ram15" successfully wiped

5.3. ボリュームグループ管理

リンクのコピーリンクがクリップボードにコピーされました!

このセクションでは、ボリュームグループ管理の各種事項を実行するためのコマンドについて説明しています。

5.3.1. ボリュームグループの作成

リンクのコピーリンクがクリップボードにコピーされました!

To create a volume group from one or more physical volumes, use the

vgcreate command. The vgcreate command creates a new volume group by name and adds at least one physical volume to it.

以下のコマンドは、

vg1 と言う名前のボリュームグループを作成します。これには、物理ボリューム /dev/sdd1 と /dev/sde1 が含まれます。

vgcreate vg1 /dev/sdd1 /dev/sde1

# vgcreate vg1 /dev/sdd1 /dev/sde1

ボリュームグループの作成に物理ボリュームが使用される場合、ディスク領域はデフォルトでは 4MB のエクステントに分割されます。このエクステントは、論理ボリュームのサイズを拡張/縮小するための最小単位です。エクステントの数が多くても、論理ボリュームの I/O パフォーマンスに影響を与えることはありません。

エクステントサイズのデフォルト設定が適切でない場合、

vgcreate コマンドに -s オプションを使用して、サイズを指定することができます。vgcreate コマンドに -p と -l の引数を使用すると、ボリュームグループに追加可能な物理ボリュームまたは論理ボリュームの数を限定することができます。

By default, a volume group allocates physical extents according to common-sense rules such as not placing parallel stripes on the same physical volume. This is the

normal allocation policy. You can use the --alloc argument of the vgcreate command to specify an allocation policy of contiguous, anywhere, or cling. In general, allocation policies other than normal are required only in special cases where you need to specify unusual or nonstandard extent allocation. For further information on how LVM allocates physical extents, see 「LVM の割り当て」.

LVM ボリュームグループと配下にある論理ボリュームは、以下のような配置で

/dev ディレクトリ内のデバイス特有のファイルがあるディレクトリツリーに格納されます。

/dev/vg/lv/

/dev/vg/lv/

For example, if you create two volume groups

myvg1 and myvg2, each with three logical volumes named lv01, lv02, and lv03, six device special files are created:

The device special files are not present if the corresponding logical volume is not currently active.

LVM でのデバイスの最大サイズは、64 ビット CPU 上で 8 エクサバイトです。

5.3.2. LVM の割り当て

リンクのコピーリンクがクリップボードにコピーされました!

LVM の操作で物理エクステントを単一または複数の論理ボリュームに割り当てる必要がある場合、割り当ては以下のように行われます。

- ボリュームグループ内で未割り当ての物理エクステントが割り当て用に生成されます。コマンドラインの末尾で物理エクステントの範囲を指定した場合は、指定した物理ボリューム上のその範囲内で未割り当ての物理エクステントのみが割り当て用として考慮に入れられます。

- 各割り当てポリシーは、最も厳しいポリシー (

contiguous) から始まり、最後は--allocオプションを使用して指定される、あるいは特定の論理ボリュームやボリュームグループ用にデフォルトとしてセットされる割り当てポリシーと、順番に試行されます。割り当てポリシーでは、埋める必要がある空の論理ボリューム領域の最少の論理エクステントから、割り当てポリシーによる制限に沿って、できるだけ多くの領域の割り当てを行います。領域がさらに必要な場合は、LVM は次のポリシーに移動します。

割り当てポリシーの制限は以下のとおりです。

contiguousの割り当てポリシーでは、論理ボリュームの 1 番目の論理エクステントではない論理エクステントは、直接先行する論理エクステントに物理的に隣接する必要があります。論理ボリュームがストライプ化またはミラー化されると、contiguousの割り当て制限が、領域を必要とする各ストライプまたはミラーイメージ (レッグ) に個別に適用されます。clingの割り当てポリシーでは、既存の論理ボリュームに追加される任意の論理エクステントに使用される物理ボリュームは、その論理ボリューム内でそれより前から 1 つ以上の論理エクステントにより使用されている必要があります。allocation/cling_tag_listの設定パラメーターが定義されている場合に、一覧表示されているいずれかのタグが 2 つの物理ボリュームに存在していると、この両方の物理ボリュームは適合すると考えられます。これにより、同じプロパティ (物理的な場所など) を持つ物理ボリュームのグループを、割り当て目的でタグして同等に処理することができます。LVM ボリュームの拡張時に使用する追加の物理ボリュームを指定する LVM タグとともに、clingポリシーの使用に関しては、「cling割り当てポリシーを使用した論理ボリュームの拡張」 をご覧ください。論理ボリュームがストライプ化またはミラー化されると、clingの割り当て制限が、領域を必要とする各ストライプまたはミラーイメージ (レッグ) に個別に適用されます。normalの割り当てポリシーは、並列の論理ボリューム (異なるストライプまたはミラーイメージ/レッグ) 内の同じオフセットで、その並列の論理ボリュームにすでに割り当て済みの論理エクステントと同じ物理ボリュームを共有する物理エクステントは選択しません。ミラーデータ保持のために論理ボリュームと同時にミラーログを割り当てる場合、normalの割り当てポリシーは最初にログやデータに対して異なる物理ボリュームを選択しようとします。それが不可能で、かつallocation/mirror_logs_require_separate_pvs設定パラメーターが 0 にセットされている場合は、ログが物理ボリュームとデータの一部を共有できるようになります。同様に、シンプールメタデータを割り当てる場合、normalの割り当てポリシーはミラーログを割り当てる場合と同じ注意事項に沿います。allocation/thin_pool_metadata_require_separate_pvs設定パラメーターの値に基づきます。- 割り当て要求を満たすだけの十分な空きエクステントがあっても

normalの割り当てポリシーがそれらを使用しない場合は、たとえパフォーマンスが低下しても、同じ物理ボリュームに 2 つのストライプを配置することによって、anywhere割り当てポリシーが使用します。

割り当てポリシーは

vgchange コマンドを使用して変更できます。

注記

If you rely upon any layout behavior beyond that documented in this section according to the defined allocation policies, you should note that this might change in future versions of the code. For example, if you supply on the command line two empty physical volumes that have an identical number of free physical extents available for allocation, LVM currently considers using each of them in the order they are listed; there is no guarantee that future releases will maintain that property. If it is important to obtain a specific layout for a particular Logical Volume, then you should build it up through a sequence of

lvcreate and lvconvert steps such that the allocation policies applied to each step leave LVM no discretion over the layout.

割り当てプロセスが特定のケースで現在実行する方法を表示するには、コマンドに

-vvvv オプションを追加するなどして、デバッグロギングの出力を読み取ることができます。

5.3.3. クラスター内でのボリュームグループ作成

リンクのコピーリンクがクリップボードにコピーされました!

vgcreate コマンドでクラスター環境内にボリュームグループを作成します。単一ノードでボリュームグループを作成する時と同様です。

By default, volume groups created with CLVM on shared storage are visible to all computers that have access to the shared storage. It is possible, however, to create volume groups that are local, visible only to one node in the cluster, by using the

-c n option of the vgcreate command.

クラスター環境内で以下のコマンドを実行すると、コマンドの実行元であるノードに対してローカルとなるボリュームグループが作成されます。このコマンドは、物理ボリュームである

/dev/sdd1 と /dev/sde1 を含むローカルボリューム vg1 を作成します。

vgcreate -c n vg1 /dev/sdd1 /dev/sde1

# vgcreate -c n vg1 /dev/sdd1 /dev/sde1

既存のボリュームグループがクラスター化したボリュームグループであるかどうかは

vgs コマンドでチェックできます。ボリュームがクラスター化されている場合は、c 属性を表示します。以下のコマンドは VolGroup00と testvg1 のボリュームグループの属性を表示します。この例では、VolGroup00 はクラスター化されていませんが、testvg1 は、Attr 見出しの下にある c 属性が示すようにクラスター化されています。

vgs VG #PV #LV #SN Attr VSize VFree VolGroup00 1 2 0 wz--n- 19.88G 0 testvg1 1 1 0 wz--nc 46.00G 8.00M

# vgs

VG #PV #LV #SN Attr VSize VFree

VolGroup00 1 2 0 wz--n- 19.88G 0

testvg1 1 1 0 wz--nc 46.00G 8.00M

5.3.4. ボリュームグループへの物理ボリュームの追加

リンクのコピーリンクがクリップボードにコピーされました!

新規に物理ボリュームを既存のボリュームグループに追加するには、

vgextend コマンドを使用します。vgextend コマンドは、1つ、または複数の空き物理ボリュームを追加することによってボリュームグループの容量を拡大します。

以下のコマンドは、物理ボリューム

/dev/sdf1 をボリュームグループ vg1 に追加します。

vgextend vg1 /dev/sdf1

# vgextend vg1 /dev/sdf15.3.5. ボリュームグループの表示

リンクのコピーリンクがクリップボードにコピーされました!

LVM ボリュームグループのプロパティを表示するのに使用できるコマンドは 2 つあります。

vgs と vgdisplay です。

vgscan コマンドは、ボリュームグループのすべてのディスクをスキャンして LVM キャッシュファイルを再構築する以外に、ボリュームグループを表示することもできます。vgscan コマンドに関する情報は 「キャッシュファイル構築のためのボリュームグループのディスクスキャン」 をご覧ください。

vgs コマンドは、ボリュームグループの情報を設定可能な形式で提供し、1 ボリュームグループにつき 1 行ずつ表示します。vgs コマンドは豊富な書式制御を提供するため、スクリプティングに役立ちます。出力をカスタマイズするための vgs コマンドの使用については、「LVM 用のカスタム報告」 をご覧ください。

The

vgdisplay command displays volume group properties (such as size, extents, number of physical volumes, and so on) in a fixed form. The following example shows the output of a vgdisplay command for the volume group new_vg. If you do not specify a volume group, all existing volume groups are displayed.

5.3.6. キャッシュファイル構築のためのボリュームグループのディスクスキャン

リンクのコピーリンクがクリップボードにコピーされました!

The

vgscan command scans all supported disk devices in the system looking for LVM physical volumes and volume groups. This builds the LVM cache file in the /etc/lvm/cache/.cache file, which maintains a listing of current LVM devices.

LVM は、システムの起動時、ならびに

vgcreate コマンドを実行した時や LVM が不整合を検出した時など、LVM が動作している他の時点で vgscan コマンドを自動的に実行します。

注記

ハードウェア構成を変更して、ノードに対してデバイスの追加/削除を行う場合、システムの起動時に存在していなかったデバイスがシステムに認識されるように

vgscan コマンドを手動で実行しなければならない場合があります。これは、例えば、SAN 上のシステムに新しいディスクを追加したり、物理ボリュームとしてラベルが付けられた新しいディスクをホットプラグする場合に必要になる可能性があります。

lvm.conf ファイル内でフィルターを定義することで、特定デバイスを避けるようにスキャンを限定できます。スキャンするデバイスを制御するためのフィルターの使用については、「フィルターを使用した LVM デバイススキャンの制御」 をご覧ください。

次の例では、

vgscan コマンドの出力を示しています。

vgscan Reading all physical volumes. This may take a while... Found volume group "new_vg" using metadata type lvm2 Found volume group "officevg" using metadata type lvm2

# vgscan

Reading all physical volumes. This may take a while...

Found volume group "new_vg" using metadata type lvm2

Found volume group "officevg" using metadata type lvm2

5.3.7. ボリュームグループからの物理ボリュームの削除

リンクのコピーリンクがクリップボードにコピーされました!

ボリュームグループから使用しない物理ボリュームを削除するには、

vgreduce コマンドを使用します。vgreduce コマンドは、1つまたは複数の空の物理ボリュームを削除することにより、ボリュームグループの容量を縮小します。これによって、物理ボリュームが開放され、異なるボリュームグループで使用したり、システムから削除できるようになります。

ボリュームグループから物理ボリュームを削除する前に、

pvdisplay コマンドを使用して、その物理ボリュームが論理ボリュームによって使用されていないことを確認することができます。

If the physical volume is still being used you will have to migrate the data to another physical volume using the

pvmove command. Then use the vgreduce command to remove the physical volume.

以下のコマンドは、物理ボリューム

/dev/hda1 を ボリュームグループ my_volume_group から取り除きます。

vgreduce my_volume_group /dev/hda1

# vgreduce my_volume_group /dev/hda1

If a logical volume contains a physical volume that fails, you cannot use that logical volume. To remove missing physical volumes from a volume group, you can use the

--removemissing parameter of the vgreduce command, if there are no logical volumes that are allocated on the missing physical volumes.

5.3.8. ボリュームグループのパラメーター変更

リンクのコピーリンクがクリップボードにコピーされました!

「ボリュームグループのアクティブ化と非アクティブ化」 で説明しているように、

vgchange コマンドは、ボリュームグループの非アクティブ化およびアクティブ化に使用されます。また、このコマンドを使用して、既存のボリュームグループを対象とする、いくつかのボリュームグループパラメーターを変更することも可能です。

以下のコマンドは、ボリュームグループ

vg00 の論理ボリュームの最大数を 128 に変更します。

vgchange -l 128 /dev/vg00

# vgchange -l 128 /dev/vg00vgchange コマンドで変更できるボリュームグループパラメーターの説明については vgchange(8) の man ページをご覧ください。

5.3.9. ボリュームグループのアクティブ化と非アクティブ化

リンクのコピーリンクがクリップボードにコピーされました!

ボリュームグループを作成すると、デフォルトでアクティブ化されます。これは、そのグループ内の論理ボリュームがアクセス可能で、かつ変更される可能性があることを意味します。

ボリュームグループを非アクティブ化して、カーネルに認識されないようにする必要がある、様々な状況があります。ボリュームグループを非アクティブ化、またはアクティブ化するには、

vgchange コマンドで -a (--available) 引数を使用します。

以下の例では、ボリュームグループ

my_volume_group を非アクティブ化します。

vgchange -a n my_volume_group

# vgchange -a n my_volume_group

クラスター化されたロッキングが有効な場合には、「e」を追加すると 1 つのノード上でボリュームグループが排他的にアクティブ化または非アクティブ化されます。「l」を追加すると、ローカルノード上のみでボリュームグループがアクティブ化または非アクティブ化されます。単一ホストのスナップショットを使用する論理ボリュームは、1 度に 1 つのノード上でしか利用できないため、常に排他的にアクティブ化されます。

「論理ボリュームグループのパラメーター変更」 で説明してあるように、

lvchange コマンドを使用して、個別の論理ボリュームを非アクティブ化できます。クラスター内の個別ノード上で論理ボリュームをアクティブ化する方法については、「クラスター内の個別ノード上の論理ボリュームのアクティブ化」 をご覧ください。

5.3.10. ボリュームグループの削除

リンクのコピーリンクがクリップボードにコピーされました!

論理ボリュームがないボリュームグループを削除するには、

vgremove コマンドを使用します。

vgremove officevg Volume group "officevg" successfully removed

# vgremove officevg

Volume group "officevg" successfully removed

5.3.11. ボリュームグループの分割

リンクのコピーリンクがクリップボードにコピーされました!

ボリュームグループの物理ボリュームを分割して、新しいボリュームグループを作成するには、

vgsplit コマンドを使用します。

論理ボリュームはボリュームグループ間で分割することはできません。それぞれの既存の論理ボリュームは完全に物理ボリューム上に存在し、既存または新規のボリュームグループを形成している必要があります。しかし必要であれば、

pvmove コマンドを使用して、その分割を強制することができます。

以下の例では、オリジナルのボリュームグループ

bigvg から新規のボリュームグループ smallvg を分割しています。

vgsplit bigvg smallvg /dev/ram15 Volume group "smallvg" successfully split from "bigvg"

# vgsplit bigvg smallvg /dev/ram15

Volume group "smallvg" successfully split from "bigvg"

5.3.12. ボリュームグループの統合

リンクのコピーリンクがクリップボードにコピーされました!

2 つのボリュームグループを統合して 1 つのボリュームグループにするには、

vgmerge コマンドを使用します。ボリュームの物理エクステントサイズが同じで、かつ両ボリュームグループの物理および論理ボリュームのサマリーが「マージ先」ボリュームグループの制限内に収まる場合は、非アクティブな「マージ元」のボリュームを、アクティブまたは非アクティブの「マージ先」ボリュームにマージすることができます。

以下のコマンドは、非アクティブなボリュームグループ

my_vg をアクティブまたは非アクティブなボリュームグループ databases にマージして、詳細なランタイム情報を提供します。

vgmerge -v databases my_vg

# vgmerge -v databases my_vg5.3.13. ボリュームグループメタデータのバックアップ

リンクのコピーリンクがクリップボードにコピーされました!

メタデータのバックアップとアーカイブは、

lvm.conf ファイル内で無効になっていない限り、すべてのボリュームグループと論理ボリューム設定の変更時に自動的に作成されます。デフォルトでは、メタデータのバックアップは /etc/lvm/backup ファイルに保存され、メタデータのアーカイブは /etc/lvm/archives ファイルに保存されます。vgcfgbackup コマンドを使用するとメタデータを /etc/lvm/backup ファイルに手動でバックアップできます。

vgcfrestore コマンドは、アーカイブからボリュームグループのメタデータをボリュームグループのすべての物理ボリュームに復元します。

物理ボリュームのメタデータを復元するための

vgcfgrestore コマンドの使用例は、「物理ボリュームメタデータの復元」 をご覧ください。

5.3.14. ボリュームグループの名前変更

リンクのコピーリンクがクリップボードにコピーされました!

既存ボリュームグループの名前を変更するには、

vgrename コマンドを使用します。

以下のいずれかのコマンドで、既存ボリュームグループ

vg02 の名前を my_volume_group に変更できます。

vgrename /dev/vg02 /dev/my_volume_group

# vgrename /dev/vg02 /dev/my_volume_groupvgrename vg02 my_volume_group

# vgrename vg02 my_volume_group5.3.15. ボリュームグループの別のシステムへの移動

リンクのコピーリンクがクリップボードにコピーされました!

LVM ボリュームグループ全体を別のシステムに移動することができます。これを実行するには、

vgexport と vgimport のコマンドの使用が推奨されます。

注記

As of Red Hat Enterprise Linux 6.5, you can use the

--force argument of the vgimport command. This allows you to import volume groups that are missing physical volumes and subsequently run the vgreduce --removemissing command.

vgexport コマンドは、システムが非アクティブのボリュームグループにアクセスできないようにするため、物理ボリュームのデタッチが可能になります。vgimport コマンドは、vgexport コマンドで停止していたボリュームグループにマシンが再度アクセスできるようにします。

ボリュームグループを 2 つのシステム間で移動するには、以下の手順に従います。

- ボリュームグループ内のアクティブなボリュームのファイルにアクセスしているユーザーがいないことを確認してから、論理ボリュームをアンマウントします。

vgchangeコマンドで-a n引数を使用して、そのボリュームグループを非アクティブとしてマークします。これによりボリュームグループがこれ以上活動しないようにします。vgexportコマンドを使用してボリュームグループをエクスポートします。これは、削除中のシステムからのボリュームグループへのアクセスを防止します。ボリュームグループをエクスポートした後に、pvscanコマンドを実行すると、以下の例のように物理ボリュームがエクスポート先のボリュームグループ内に表示されます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow システムが次回シャットダウンされる時に、ボリュームグループを構成していたディスクを切断して、それらを新しいシステムに接続することができます。- ディスクが新しいシステムに接続されると、

vgimportコマンドを使用してボリュームグループをインポートし、新しいシステムにアクセスできるようにします。 vgchangeコマンドで-a y引数を使用してボリュームグループをアクティブ化します。- ファイルシステムをマウントして使用可能にします。

5.3.16. ボリュームグループディレクトリの再作成

リンクのコピーリンクがクリップボードにコピーされました!

ボリュームグループディレクトリと論理ボリューム特別ファイルを再作成するには、

vgmknodes コマンドを使用します。このコマンドは、/dev ディレクトリ内の LVM2 特別ファイルをチェックします。このファイルはアクティブな論理ボリュームに必要です。このコマンドは不足している特別ファイルを作成し、未使用のファイルを削除します。

vgscan コマンドに mknodes 引数を指定することにより、vgmknodes コマンドを vgscan コマンドに統合することができます。

5.4. 論理ボリュームの管理

リンクのコピーリンクがクリップボードにコピーされました!

このセクションでは、論理ボリューム管理の各種事項を実行するコマンドを説明しています。

5.4.1. リニア論理ボリュームの作成

リンクのコピーリンクがクリップボードにコピーされました!

論理ボリュームを作成するには、

lvcreate コマンドを使用します。論理ボリューム用に名前を指定しないと、デフォルトの名前 lvol# が使用されます (# の部分には論理ボリュームの内部番号が入ります)。

論理ボリュームを作成する場合、論理ボリュームはボリュームグループを構成する物理ボリューム上の空きエクステントを使用してボリュームグループから構築されます。通常は論理ボリュームは配下の物理ボリューム上で次に使用可能な空きを基準にして空き領域を占有します。論理ボリュームを変更することで、物理ボリューム内の領域の開放と再割り当てができます。

As of the Red Hat Enterprise Linux 6.3 release, you can use LVM to create, display, rename, use, and remove RAID logical volumes. For information on RAID logical volumes, see 「RAID 論理ボリューム」.

以下のコマンドは、ボリュームグループ

vg1 内に 10 ギガバイトのサイズの論理ボリュームを作成します。

lvcreate -L 10G vg1

# lvcreate -L 10G vg1

The default unit for logical volume size is megabytes. The following command creates a 1500 MB linear logical volume named

testlv in the volume group testvg, creating the block device /dev/testvg/testlv.

lvcreate -L 1500 -n testlv testvg

# lvcreate -L 1500 -n testlv testvg

次のコマンドは、ボリュームグループ

vg0 内の空きエクステントから gfslv と言う 50 ギガバイトの論理ボリュームを作成します。

lvcreate -L 50G -n gfslv vg0

# lvcreate -L 50G -n gfslv vg0lvcreate コマンドで -l 引数を使用すると、エクステント内の論理ボリュームのサイズを指定することができます。この引数を使用すると、論理ボリュームに使用するボリュームグループのパーセンテージも指定できます。以下のコマンドは、ボリュームグループ testvg 内で全体の 60% を使用する mylv と呼ばれる論理ボリュームを作成します。

lvcreate -l 60%VG -n mylv testvg

# lvcreate -l 60%VG -n mylv testvglvcreate コマンドで -l 引数を使用すると、ボリュームグループ内で残っている空き領域のパーセンテージを、論理ボリュームのサイズとして指定することもできます。以下のコマンドは、ボリュームグループ testvol 内の未割り当て領域をすべて使用する yourlv と呼ばれる論理ボリュームを作成します。

lvcreate -l 100%FREE -n yourlv testvg

# lvcreate -l 100%FREE -n yourlv testvglvcreate コマンドで、-l 引数を使用して、ボリュームグループ全域を使用する論理ボリュームを作成することができます。ボリュームグループ全域を使用する論理ボリュームを作成する別の方法としては、vgdisplay コマンドを使用して「合計 PE」サイズを確認し、その結果を lvcreate コマンドへのインプットとして使用することです。

以下のコマンドは、

testvg と言うボリュームグループ全域を使用する mylv と言う論理ボリュームを作成します。

vgdisplay testvg | grep "Total PE" Total PE 10230 lvcreate -l 10230 testvg -n mylv

# vgdisplay testvg | grep "Total PE"

Total PE 10230

# lvcreate -l 10230 testvg -n mylv

論理ボリュームの作成に使用した、配下の物理ボリュームは、物理ボリュームを削除する必要がある場合に重要となる可能性があります。そのため、論理ボリュームを作成する時にはこの可能性を考慮する必要があります。ボリュームグループから物理ボリュームを削除する方法についての情報は、「ボリュームグループからの物理ボリュームの削除」 をご覧ください。

ボリュームグループ内の特定の物理ボリュームから割り当てる論理ボリュームを作成するには、

lvcreate コマンドラインの末尾に物理ボリュームを指定する必要があります。以下のコマンドは、物理ボリューム /dev/sdg1 から割り当てられるボリュームグループ testvg 内に論理ボリューム testlv を作成します。

lvcreate -L 1500 -ntestlv testvg /dev/sdg1

# lvcreate -L 1500 -ntestlv testvg /dev/sdg1

論理ボリュームに使用する物理ボリュームのエクステントを指定することができます。以下の例では、ボリュームグループ

testvg 内にエクステントが 0 から 24 の物理ボリューム /dev/sda1 およびエクステントが 50 から 124 の物理ボリューム /dev/sdb1 のリニア論理ボリュームを作成します。

lvcreate -l 100 -n testlv testvg /dev/sda1:0-24 /dev/sdb1:50-124

# lvcreate -l 100 -n testlv testvg /dev/sda1:0-24 /dev/sdb1:50-124

以下の例では、エクステントが 0 から 25 の物理ボリューム

/dev/sda1 からリニア論理ボリュームを作成した後に、エクステントが 100 の論理ボリュームを配置しています。

lvcreate -l 100 -n testlv testvg /dev/sda1:0-25:100-

# lvcreate -l 100 -n testlv testvg /dev/sda1:0-25:100-

論理ボリュームのエクステントが割り当てられる方法についてのデフォルトポリシーは、

inherit であり、ボリュームグループ用の同じポリシーに適用されます。これらのポリシーは lvchange コマンドを使用して変更できます。割り当てポリシーの詳細については、「ボリュームグループの作成」 をご覧ください。

5.4.2. ストライプ化ボリュームの作成

リンクのコピーリンクがクリップボードにコピーされました!

大量の連続的な読み取りと書き込みを行う場合、ストライプ化論理ボリュームを作成すると、データ I/O が効率化されます。ストライプ化ボリュームに関する一般情報は、「ストライプ化論理ボリューム」 をご覧ください。

ストライプ化論理ボリュームを作成する時には、

lvcreate コマンドで -i 引数を使用してストライプの数を指定します。これは、論理ボリュームがストライプ化される物理ボリュームの数を決定します。ストライプ数は、ボリュームグループ内の物理ボリュームの数よりも多くすることはできません (--alloc anywhere 引数が使用される場合は例外)。

ストライプ化論理ボリュームを構成する配下の物理デバイスのサイズが異なる場合、ストライブ化ボリュームの最大サイズはその配下の最小デバイスで決定されます。例えば、2 レッグのストライプがある場合、最大サイズは小さいデバイスの 2 倍になります。3 レッグのストライプの場合、最大サイズは最小デバイスの 3 倍になります。

以下のコマンドは、64KB のストライプを持つ 2 つの物理ボリュームに渡ってストライプ化論理ボリュームを作成します。論理ボリュームのサイズは 50 ギガバイトで、

gfslv と呼ばれ、ボリュームグループ vg0 から作り出されます。

lvcreate -L 50G -i2 -I64 -n gfslv vg0

# lvcreate -L 50G -i2 -I64 -n gfslv vg0

リニアボリュームと同じく、ストライプに使用する物理ボリュームのエクステントを指定することができます。以下のコマンドは、2 つの物理ボリュームに渡ってストライプ化する、

stripelv と呼ばれる 100 エクステントのストライプ化ボリュームを testvg のボリュームグループ内に作成します。ストライプは /dev/sda1 のセクター 0-49 と /dev/sdb1 のセクター 50-99 を使用します。

lvcreate -l 100 -i2 -nstripelv testvg /dev/sda1:0-49 /dev/sdb1:50-99 Using default stripesize 64.00 KB Logical volume "stripelv" created

# lvcreate -l 100 -i2 -nstripelv testvg /dev/sda1:0-49 /dev/sdb1:50-99

Using default stripesize 64.00 KB

Logical volume "stripelv" created

5.4.3. ミラー化ボリュームの作成

リンクのコピーリンクがクリップボードにコピーされました!

注記

As of the Red Hat Enterprise Linux 6.3 release, LVM supports RAID4/5/6 and a new implementation of mirroring. For information on this new implementation, see 「RAID 論理ボリューム」.

注記

ミラー化された LVM 論理ボリュームをクラスター内に作成するには、単一ノード上でミラー化論理ボリュームを作成するのと同じコマンドと手順が必要です。しかし、クラスター内にミラー化 LVM ボリュームを作成するには、クラスターとクラスターミラーインフラストラクチャーが稼動中であり、クラスターが定足数を満たしており、かつクラスターロッキングを有効化するように

lvm.conf ファイル内のロッキングタイプが正しく設定されている必要があります。クラスター内におけるミラー化ボリューム作成の例については、「クラスター内でのミラー化 LVM 論理ボリュームの作成」 をご覧ください。

単一のクラスター内の複数のノードから短時間に連続して複数の LVM ミラー作成および変換コマンドを実行しようとすると、これらのコマンドのバックログが生じる場合があります。これによって、要求した動作がタイムアウトとなった後で失敗となる可能性があります。この問題を回避するために、クラスターミラー作成コマンドは、そのクラスターの単一ノードから実行することを推奨します。

ミラー化ボリュームを作成する場合、

lvcreate コマンドの -m 引数を使用して、データのコピー数を指定します。-m1 と指定すると、1 つのミラーが作成され、ファイルシステムのコピーが合計 2 つとなります (1 つのリニア論理ボリュームと 1 つのコピー)。同じように -m2 と指定すると、2 つのミラーが作成され、ファイルシステムのコピーが合計 3 つとなります。

以下のコマンドは、単一のミラーを持つミラー化論理ボリュームを作成します。ボリュームのサイズは 50 ギガバイトで、

mirrorlv と呼ばれ、ボリュームグループ vg0 から作り出されます。

lvcreate -L 50G -m1 -n mirrorlv vg0

# lvcreate -L 50G -m1 -n mirrorlv vg0

デフォルトでは、LVM ミラーデバイスは、複製されるデバイスをサイズが 512KB のリージョンに分割します。

lvcreate コマンドで -R 引数を使用して、リージョンサイズをメガバイト単位で指定できます。また、lvm.conf ファイル内の mirror_region_size 設定を変更して、デフォルトのリージョンサイズを変更することも可能です。

注記

クラスターインフラストラクチャーの制限により、デフォルトのリージョンサイズが 512KB では、1.5TB を超えるクラスターミラーは作成できません。1.5TB よりも大きなミラーを必要とするユーザーは、リージョンサイズをデフォルトよりも大きくする必要があります。リージョンサイズを大きくしておかないと、LVM の作成がハングしてしまい、またその他の LVM コマンドもハングしてしまう可能性もあります。

1.5TB を超えるミラー用のリージョンサイズを指定するための一般的なガイドラインとして、ミラーサイズをテラバイト単位で考えて、2 の次の累乗に切り上げ、その数を

lvcreate コマンドの -R 引数として使用することができます。例えば、ミラーサイズが 1.5TB の場合、-R 2 と指定することができます。また、ミラーサイズが 3TB の場合は -R 4、5TB の場合は -R 8と指定することができます。

以下のコマンドは、リージョンサイズが 2MB のミラー化論理ボリュームを作成します。

lvcreate -m1 -L 2T -R 2 -n mirror vol_group

# lvcreate -m1 -L 2T -R 2 -n mirror vol_group

ミラーが作成されると、ミラーのリージョンは同期されます。大きなミラーコンポーネントの場合は、同期プロセスに長時間かかる可能性があります。Red Hat Enterprise Linux 6.3 では、再開が不要な新規のミラーを作成している場合は、

--nosync 引数を指定して、最初のデバイスからの初期同期化は不要であることを示すことができます。

LVM maintains a small log which it uses to keep track of which regions are in sync with the mirror or mirrors. By default, this log is kept on disk, which keeps it persistent across reboots and ensures that the mirror does not need to be resynced every time a machine reboots or crashes. You can specify instead that this log be kept in memory with the

--mirrorlog core argument; this eliminates the need for an extra log device, but it requires that the entire mirror be resynchronized at every reboot.

以下のコマンドは、ボリュームグループ

bigvg からミラー化論理ボリュームを作成します。論理ボリュームは、ondiskmirvol と呼ばれ、単一のミラーがあります。ボリュームのサイズは 12MB で、ミラーログをメモリーに保存します。

lvcreate -L 12MB -m1 --mirrorlog core -n ondiskmirvol bigvg Logical volume "ondiskmirvol" created

# lvcreate -L 12MB -m1 --mirrorlog core -n ondiskmirvol bigvg

Logical volume "ondiskmirvol" created

このミラーログは、いずれかのミラーレッグが作成されるデバイスとは異なるデバイス上で作成されます。しかし、

vgcreate コマンドに --alloc anywhere 引数を使用することにより、ミラーレッグの 1 つと同じデバイス上にミラーログを作成することが可能です。これはパフォーマンスを低下させる可能性がありますが、配下のデバイスが 2 つしかない場合でもミラーを作成できます。

以下のコマンドは、単一のミラーを持つミラー化論理ボリュームを作成します。このミラーログはミラーレッグの 1 つと同じデバイス上にあります。この例では、ボリュームグループ

vg0 は 2 つのデバイスのみで構成されています。このコマンドによって、ボリュームグループ vg0 内に mirrorlv という名前で、サイズが 500 MB のボリュームが作成されます。

lvcreate -L 500M -m1 -n mirrorlv -alloc anywhere vg0

# lvcreate -L 500M -m1 -n mirrorlv -alloc anywhere vg0注記

クラスター化されたミラーでは、ミラーログ管理は、その時点でクラスター ID が最も低いクラスターノードの完全な責任です。そのため、クラスターミラーログを保持するデバイスがクラスターのサブセット上で利用できない場合、最も低い ID のクラスターノードがミラーログへのアクセスを維持している限りは、クラスター化されたミラーは影響を受けることなく、操作を持続することができます。ミラーは影響を受けないため、自動修正アクション (修復) も生じません。ただし、最も低い ID のクラスターノードがミラーログにアクセスできなくなると、(他のノードからログへのアクセスが可能か否かにかかわらず) 自動アクションが作動します。

自動的にミラー化されるミラーログを作成するために、

--mirrorlog mirrored 引数を指定することができます。以下のコマンドはボリュームグループ bigvg からミラー化論理ボリュームを作成します。論理ボリュームは twologvol と言う名前で、単一のミラーを持ちます。このボリュームのサイズは 12MB で、ミラーログがミラー化され、各ログは別個のデバイス上に保管されます。

lvcreate -L 12MB -m1 --mirrorlog mirrored -n twologvol bigvg Logical volume "twologvol" created

# lvcreate -L 12MB -m1 --mirrorlog mirrored -n twologvol bigvg

Logical volume "twologvol" created

標準ミラーログと同様に、

vgcreate コマンドの --alloc anywhere 引数を使用してミラーレッグと同じデバイス上に冗長ミラーログを作成することが可能です。これによってパフォーマンスが低下する可能性がありますが、各ログを別個のデバイス上に保管するための配下のデバイス数がミラーレッグに対して十分でない場合でも、冗長ミラーログの作成が可能となります。

ミラーが作成されると、ミラーのリージョンは同期されます。大きなミラーコンポーネントの場合は、同期プロセスに長時間かかる可能性があります。再開が不要な新規のミラーを作成している場合は、

--nosync 引数を指定して、最初のデバイスからの初期同期化は不要であることを示すことができます。

ミラーレッグとログ用に使用するデバイス、およびそのデバイスで使用するエクステントを指定することができます。ログを特定のディスクに強制するには、それが配置されるディスク上のエクステントを正確に 1 つ指定します。LVM は、コマンドラインでデバイスが一覧表示される順序を必ずしも優先しません。物理ボリュームが一覧にあれば、それが割り当てを実行する唯一のスペースです。既に割り当て済みの物理エクステントが一覧にあれば、それは無視されます。

以下のコマンドは、単一のミラーを持つミラー化論理ボリュームを作成します。このボリュームのサイズは 500 MB で、

mirrorlv と呼ばれ、ボリュームグループ vg0 から作り出されます。第 1 のミラーレッグはデバイス /dev/sda1 上、第 2 のミラーレッグはデバイス /dev/sdb1 上、そのミラーログは /dev/sdc1 上にあります。

lvcreate -L 500M -m1 -n mirrorlv vg0 /dev/sda1 /dev/sdb1 /dev/sdc1

# lvcreate -L 500M -m1 -n mirrorlv vg0 /dev/sda1 /dev/sdb1 /dev/sdc1

以下のコマンドは、単一のミラーを持つミラー化論理ボリュームを作成します。このボリュームサイズは 500 MB で、

mirrorlv と呼ばれ、ボリュームグループ vg0 から作り出されます。第 1 のミラーレッグは、エクステントが 0 から 499 のデバイス /dev/sda1 にあり、第 2 のミラーレッグはエクステントが 0 から 499 のデバイス /dev/sdb1 にあります。ミラーログは、エクステントが 0 のデバイス /dev/sdc1 から始まります。これらは 1MB のエクステントです。指定されたエクステントのいずれかが既に割り当て済みの場合は、それらは無視されます。

lvcreate -L 500M -m1 -n mirrorlv vg0 /dev/sda1:0-499 /dev/sdb1:0-499 /dev/sdc1:0

# lvcreate -L 500M -m1 -n mirrorlv vg0 /dev/sda1:0-499 /dev/sdb1:0-499 /dev/sdc1:0注記

Red Hat Enterprise Linux 6.1 リリースでは、単一の論理ボリューム内でストライピングとミラーリングを併用することが可能です。論理ボリュームの作成と同時にミラーの数 (

--mirrors X) とストライプの数 (--stripes Y) を指定すると、ミラーデバイスの構成デバイスがストライプ化されます。

5.4.3.1. ミラー化論理ボリュームの障害ポリシー

リンクのコピーリンクがクリップボードにコピーされました!

lvm.conf ファイルの activation セクション内の mirror_image_fault_policy と mirror_log_fault_policy のパラメーターを使用すると、デバイスの障害が発生した場合にミラー化論理ボリュームがどのような動作をするかを定義することができます。これらのパラメーターが remove に設定されると、システムは障害のあるデバイスを削除して、そのデバイスなしで稼働を試みます。このパラメーター allocate に設定されていると、システムは障害のあるデバイスを削除して、そのデバイスの代わりとなる新たなデバイス上でのスペースの割り当てを試みます。代わりに割り当てることができる適切なデバイスとスペースがない場合、このポリシーは remove ポリシーと同様に機能します。

By default, the

mirror_log_fault_policy parameter is set to allocate. Using this policy for the log is fast and maintains the ability to remember the sync state through crashes and reboots. If you set this policy to remove, when a log device fails the mirror converts to using an in-memory log and the mirror will not remember its sync status across crashes and reboots and the entire mirror will be resynced.

デフォルトでは、

mirror_image_fault_policy パラメーターは remove に設定されています。このポリシーでは、ミラーイメージに障害が発生すると、良好なコピーが1つしか残っていない場合は、ミラーが非ミラー化デバイスに変換されます。ミラーデバイスに対してこのポリシーをallocate に設定すると、ミラーはデバイスを再同期する必要があるため、処理に時間がかかりますが、これによってデバイスのミラー特性を保持することができます。

注記

LVM ミラーにデバイス障害が発生すると、2 段階のリカバリが実行されます。第 1 段階では、障害が発生したデバイスの削除が行われます。これによってミラーは、単一のリニアデバイスに縮小されます。第 2 段階では、

mirror_log_fault_policy パラメーターが allocate に設定されている場合、障害の発生したデバイスの置き換えを試みます。ただし、第 2 段階で、ミラーが以前使用していたデバイスの中で、障害の要因となったデバイスが利用可能な場合には、障害とは関係のないデバイスが選択されるという保証はない点に注意してください。

For information on manually recovering from an LVM mirror failure, see 「LVM ミラー障害からの回復」.

5.4.3.2. ミラー化論理ボリュームの冗長イメージの分割

リンクのコピーリンクがクリップボードにコピーされました!

ミラー化論理ボリュームの冗長イメージを分割して、新たな論理ボリュームを形成することが可能です。イメージを分割するには、

lvconvert コマンドの --splitmirrors 引数を使用して、分割する冗長イメージの数を指定します。新たに分割する論理ボリュームの名前を指定するには、このコマンドの --name 引数を使用する必要があります。

以下のコマンドは、ミラー化論理ボリューム

vg/lv から、copy という名前の新たな論理ボリュームを分割します。新しい論理ボリュームには 2 つのミラーレッグが含まれます。この例では、LVM は分割するデバイスを選択しています。

lvconvert --splitmirrors 2 --name copy vg/lv

# lvconvert --splitmirrors 2 --name copy vg/lv

分割するデバイスを指定することが可能です。以下のコマンドは、ミラー化論理ボリューム

vg/lv から copy という名前の新たな論理ボリュームを分割します。新しい論理ボリュームには、/dev/sdc1 と /dev/sde1 のデバイスで構成される、2 つのミラーレッグが含まれます。

lvconvert --splitmirrors 2 --name copy vg/lv /dev/sd[ce]1

# lvconvert --splitmirrors 2 --name copy vg/lv /dev/sd[ce]15.4.3.3. ミラー化論理ボリュームの修復

リンクのコピーリンクがクリップボードにコピーされました!

lvconvert --repair コマンドを使用すると、ディスク障害後にミラーを修復することができます。これによって、ミラーは整合性のある状態に戻ります。lvconvert --repair コマンドは、インタラクティブなコマンドで、障害のあるデバイスの置き換えをシステムが試みるようにしたいかどうかのプロンプトを表示します。

- プロンプトをスキップして障害の発生したデバイスをすべて置き換えるには、コマンドライン上で

-yオプションを指定します。 - プロンプトをスキップして、障害の発生したデバイスを一切置き換えないようにするには、コマンドライン上で

-fオプションを指定します。 - プロンプトをスキップしつつ、ミラーイメージとミラーログを対象とする異なる置き換えポリシーを示すには、

--use-policies引数を指定して、lvm.confファイル内のmirror_log_fault_policyとmirror_device_fault_policyのパラメーターによって指定されているデバイス置き換えポリシーを使用することができます。

5.4.3.4. ミラー化ボリューム設定の変更

リンクのコピーリンクがクリップボードにコピーされました!

lvconvert コマンドを使用して論理ボリュームが含むミラーの数の増減を行うことができます。これにより、論理ボリュームをミラー化ボリュームからリニアボリュームに、またはリニアボリュームからミラー化ボリュームに変換できます。また、このコマンドを使用して、corelog などの既存の論理ボリュームの他のミラーパラメーターも再設定できます。

When you convert a linear volume to a mirrored volume, you are creating mirror legs for an existing volume. This means that your volume group must contain the devices and space for the mirror legs and for the mirror log.

ミラーレッグを 1 つ失うと、LVM はそのボリュームをリニアボリュームに変換して、ミラー冗長なしでもボリュームへのアクセスを可能にします。そのレッグを置き換えた後は、

lvconvert コマンドを使用して、ミラーを復元できます。この手順は 「LVM ミラー障害からの回復」 で説明してあります。

以下のコマンドは、リニア論理ボリューム

vg00/lvol1 をミラー化論理ボリュームに変換します。

lvconvert -m1 vg00/lvol1

# lvconvert -m1 vg00/lvol1

以下のコマンドは、ミラー化論理ボリューム

vg00/lvol1 をリニア論理ボリュームに変換して、ミラーレッグを削除します。

lvconvert -m0 vg00/lvol1

# lvconvert -m0 vg00/lvol1

以下のコマンドは、既存の論理ボリューム

vg00/lvol1 にミラーレッグを追加します。この例は、lvconvert コマンドがそのボリュームを 2 つのミラーレッグがあるボリュームに変更する前と後のボリュームの設定を示しています。

5.4.4. シンプロビジョニングされた論理ボリュームの作成

リンクのコピーリンクがクリップボードにコピーされました!

As of the Red Hat Enterprise Linux 6.4 release, logical volumes can be thinly provisioned. This allows you to create logical volumes that are larger than the available extents. Using thin provisioning, you can manage a storage pool of free space, known as a thin pool, which can be allocated to an arbitrary number of devices when needed by applications. You can then create devices that can be bound to the thin pool for later allocation when an application actually writes to the logical volume. The thin pool can be expanded dynamically when needed for cost-effective allocation of storage space.

注記

This section provides an overview of the basic commands you use to create and grow thinly-provisioned logical volumes. For detailed information on LVM thin provisioning as well as information on using the LVM commands and utilities with thinly-provisioned logical volumes, see the

lvmthin(7) man page.

注記

シンボリュームはクラスターのノード間ではサポートされません。シンプールとそのすべてのシンボリュームは、1 つのクラスターノードでのみ排他的にアクティブ化する必要があります。

シンプロビジョニングされたボリュームを作成するには、以下のタスクを実行してください。

vgcreateコマンドを使用して、ボリュームグループを作成します。lvcreateコマンドを使用して、シンプールを作成します。lvcreateコマンドを使用して、シンプール内にシンプロビジョニングされたボリュームを作成します。

lvcreate コマンドに -T (または --thin) オプションを使用して、シンプールまたはシンプロビジョニングされたボリュームを作成します。また、lvcreate コマンドの -T オプションを使用して、1 つのコマンドで同時にプール内にシンプールとシンプロビジョニングされたボリュームの両方を作成することも可能です。

以下のコマンドは、

lvcreate コマンドに -T オプションを使用して、mythinpool と呼ばれるシンプールを作成します。これは、ボリュームグループ vg001 内にあり、サイズは 100M です。物理領域のプールを作成しているため、プールのサイズを指定する必要があります。lvcreate コマンドの -T オプションは引数を取りません。コマンドが指定する他のオプションから作成されるデバイスのタイプを推定します。

以下のコマンドは、

lvcreate コマンドに -T オプションを使用して、シンプール vg001/mythinpool に thinvolume と呼ばれるシンプロビジョニングされたボリュームを作成します。ここでは、仮想サイズを指定して、ボリュームを含むプールよりも大きなボリュームの仮想サイズを指定している点に注意してください。

以下のコマンドは、

lvcreate コマンドに -T オプションを使用して、プール内にシンプールとシンプロビジョニングされたボリュームを作成します。その際、lvcreate コマンドでサイズと仮想サイズの引数を指定します。また、このコマンドは、ボリュームグループ vg001 内に mythinpool と呼ばれるシンプールを作成し、そのプール内に thinvolume と呼ばれるシンプロビジョニングされたボリュームも作成します。

また、

lvcreate コマンドの --thinpool パラメーターを指定して、シンプールを作成することも可能です。-T オプションとは異なり、--thinpool パラメーターには作成しているシンプール論理ボリューム名の引数が必要です。以下の例は、lvcreate コマンドで --thinpool パラメーターを指定して、mythinpool と呼ばれるシンプールを作成します。これは、ボリュームグループ vg001 内にあり、サイズは 100M です。

プール作成用に、ストライピングはサポートされています。以下のコマンドは、2 つの 64 kB のストライプと 256 kB のチャンクサイズがあるボリュームグループ

vg001 内に pool と呼ばれる 100M のシンプールを作成します。また、1T のシンプロビジョニングされたボリューム vg00/thin_lv も作成します。

lvcreate -i 2 -I 64 -c 256 -L100M -T vg00/pool -V 1T --name thin_lv

# lvcreate -i 2 -I 64 -c 256 -L100M -T vg00/pool -V 1T --name thin_lvlvextend コマンドを使用してシンプロビジョニングされたボリュームのサイズを拡張できます。ただし、シンプールのサイズを縮小することはできません。

以下のコマンドは、既存のシンプールのサイズ (100M) を変更し、100M 拡張します。

他の論理ボリュームのタイプと同様に、

lvrename を使用してボリューム名の変更、lvremove を使用してボリュームの削除、lvs と lvdisplay のコマンドを使用してボリュームの情報の表示を行うことができます。

By default, the

lvcreate command sets the size of the thin pool's metadata logical volume according to the formula (Pool_LV_size / Pool_LV_chunk_size * 64). You cannot currently resize the metadata volume, however, so if you expect significant growth of the size of thin pool at a later time you should increase this value with the --poolmetadatasize parameter of the lvcreate command. The supported value for the thin pool's metadata logical volume is in the range between 2MiB and 16GiB.

You can use the

--thinpool parameter of the lvconvert command to convert an existing logical volume to a thin pool volume. When you convert an existing logical volume to a thin pool volume, you must use the --poolmetadata parameter in conjunction with the --thinpool parameter of the lvconvert to convert an existing logical volume to the thin pool volume's metadata volume.

注記

Converting a logical volume to a thin pool volume or a thin pool metadata volume destroys the content of the logical volume, since in this case the

lvconvert does not preserve the content of the devices but instead overwrites the content.

The following example converts the existing logical volume

lv1 in volume group vg001 to a thin pool volume and converts the existing logical volume lv2 in volume group vg001 to the metadata volume for that thin pool volume.

lvconvert --thinpool vg001/lv1 --poolmetadata vg001/lv2 Converted vg001/lv1 to thin pool.

# lvconvert --thinpool vg001/lv1 --poolmetadata vg001/lv2

Converted vg001/lv1 to thin pool.

5.4.5. スナップショットボリュームの作成

リンクのコピーリンクがクリップボードにコピーされました!

注記

As of the Red Hat Enterprise Linux 6.4 release, LVM supports thinly-provisioned snapshots. For information on creating thinly provisioned snapshot volumes, see 「シンプロビジョニングされたスナップショットボリュームの作成」.

スナップショットボリュームを作成するには、

lvcreate コマンドで -s 引数を使用します。スナップショットボリュームは書き込み可能です。

注記

LVM スナップショットは、クラスター内のノード間ではサポートされていません。クラスター化されたボリュームグループ内にスナップショットボリュームは作成できません。ただし、Red Hat Enterprise Linux 6.1 リリースでは、クラスター化論理ボリューム上で恒常的なデータのバックアップ作成が必要な場合、ボリュームを排他的にアクティブ化した上で、スナップショットを作成することができます。ノード上における論理ボリュームの排他的なアクティブ化についての情報については、「クラスター内の個別ノード上の論理ボリュームのアクティブ化」 をご覧ください。

注記

Red Hat Enterprise Linux 6.1 リリースでは、ミラー化論理ボリュームを対象とした LVM スナップショットがサポートされています。

As of the Red Hat Enterprise Linux 6.3 release, snapshots are supported for RAID logical volumes. For information on RAID logical volumes, see 「RAID 論理ボリューム」.

As of the Red Hat Enterprise Linux 6.5 release, LVM does not allow you to create a snapshot volume that is larger than the size of the origin volume plus needed metadata for the volume. If you specify a snapshot volume that is larger than this, the system will create a snapshot volume that is only as large as will be needed for the size of the origin.

By default, a snapshot volume is skipped during normal activation commands. For information on controlling the activation of a snapshot volume, see 「Controlling Logical Volume Activation」.

以下のコマンドは、

/dev/vg00/snap と言う名前の 100 MB のスナップショット論理ボリュームを作成します。これは、/dev/vg00/lvol1 と呼ばれる複製元となる論理ボリュームのスナップショットを作成します。複製元となる論理ボリュームに、ファイルシステムが含まれている場合、任意のディレクトリ上でスナップショット論理ボリュームをマウントして、そのファイルシステムのコンテンツにアクセスして、複製元のファイルシステムが更新を継続している間にバックアップを実行することができます。

lvcreate --size 100M --snapshot --name snap /dev/vg00/lvol1

# lvcreate --size 100M --snapshot --name snap /dev/vg00/lvol1

スナップショット論理ボリュームを作成した後に、

lvdisplay コマンドで、複製元のボリュームを指定すると、すべてのスナップショット論理ボリュームとそのステータス (アクティブまたは非アクティブ) の一覧が出力されます。

以下の例は、論理ボリューム

/dev/new_vg/lvol0 のステータスを示しています。これに対して、スナップショットボリューム /dev/new_vg/newvgsnap が作成されています。

デフォルトでは

lvs コマンドは、元のボリュームと、各スナップショットボリューム用に使用されているスナップショットボリュームの現在のパーセンテージを表示します。以下の例は、論理ボリューム /dev/new_vg/lvol0 を含むシステム用の lvs コマンドのデフォルト出力を示しています。スナップショットボリューム /dev/new_vg/newvgsnap はこの論理ボリューム用に作成されています。

lvs LV VG Attr LSize Origin Snap% Move Log Copy% lvol0 new_vg owi-a- 52.00M newvgsnap1 new_vg swi-a- 8.00M lvol0 0.20

# lvs

LV VG Attr LSize Origin Snap% Move Log Copy%

lvol0 new_vg owi-a- 52.00M

newvgsnap1 new_vg swi-a- 8.00M lvol0 0.20

警告

複製元ボリュームが変更されると、スナップショットのサイズが拡大されるため、

lvs コマンドを使用して、スナップショットボリュームのパーセンテージを定期的に監視して、満杯にならないように確認することが重要です。100% 満杯のスナップショットは、完全に消失します。これは、複製元ボリュームの無変更部分への書き込みが、スナップショットを破損せずには成功させることができないためです。

Red Hat Enterprise Linux 6.2 リリースでは、スナップショット関連の新機能が 2 つあります。1 つ目は、スナップショットが満杯になったときに無効になるスナップショットに加えて、そのスナップショットデバイスにマウントされているすべてのファイルシステムは強制的にマウント解除されます。これにより、マウントポイントへのアクセス時に必ず発生するファイルシステムエラーを防止しようとします。2 つ目は、