High Availability Add-On リファレンス

Red Hat Enterprise Linux 7

High Availability Add-On の設定および管理のためのリファレンスガイド

概要

『Red Hat High Availability Add-On リファレンス』は、Red Hat Enterprise Linux 7 向けの Red Hat High Availability Add-On をインストール、設定、および管理するための参考情報を提供します。

第1章 Red Hat High Availability Add-On 設定および管理リファレンスの概要

本章では、Pacemaker を使用する Red Hat High Availability Add-On がサポートするオプションと機能について説明します。ステップごとの基本設定の例は『Red Hat High Availability Add-On の管理』を参照してください。

pcs 設定インターフェイスまたは pcsd GUI インターフェイスを使用して、Red Hat High Availability Add-On クラスターを設定できます。

1.1. 新機能と変更点

本セクションでは、Red Hat Enterprise Linux 7 の初回リリース以降に追加された Red Hat High Availability Add-On の新機能を取り上げます。

1.1.1. Red Hat Enterprise Linux 7.1 の新機能および変更された機能

Red Hat Enterprise Linux 7.1 には、ドキュメントや機能を対象とする以下の更新および変更が含まれています。

- Red Hat Enterprise Linux 7.1 より、pcs acl コマンドを使用してローカルユーザーのパーミッションを設定し、アクセス制御リスト(ACL)を使用してクラスター設定への読み取り専用アクセスまたは読み書きアクセスを許可できます。ACL の詳細は、「ユーザーのパーミッション設定」 を参照してください。

- 「順序付けされたリソースセット」 および 「リソースのコロケーション」 が大幅に更新および明確化されました。

- 「クォーラムオプションの設定」 に、クォーラムの確立時にクラスターがすべてのノードを待たないようにする cluster quorum unblock 機能が記載されています。

- 「リソースの作成」 に、リソースグループの順序付けを設定するために使用できる pcs resource create コマンドの

beforeおよびafterパラメーターの説明が追加されました。 - Red Hat Enterprise Linux 7.1 リリースでは、クラスター設定を tarball にバックアップし、pcs config コマンドの

backupおよび restore オプションを使用して、バックアップからすべてのノードのクラスター設定ファイルを復元できます。この機能の詳細は 「クラスター設定のバックアップおよび復元」 を参照してください。 - 内容を明確にするため本書全体に小変更が加えられました。

1.1.2. Red Hat Enterprise Linux 7.2 の新機能および変更された機能

Red Hat Enterprise Linux 7.2 ではドキュメントと機能が以下のように更新/変更されています。

- pcs resource relocate run コマンドを使用して、現在のクラスターのステータス、制約、リソースの場所、およびその他の設定によって決定される優先ノードにリソースを移行できるようになりました。このコマンドの詳細は、「リソースの優先ノードへの移動」 を参照してください。

- 「モニタリングのリソースを使ったイベント通知」 外部プログラムを実行してクラスター通知の処理を判断するために

ClusterMonリソースを設定する方法をより深く説明するため、変更および拡張されました。 - 冗長な電源供給用のフェンスを設定する場合に各デバイスを 1 度のみ設定する必要があり、ノードのフェンシングには両方のデバイスが必要になることを指定する必要があります。冗長な電源供給にフェンスを設定する方法の詳細は、「冗長電源のフェンシング設定」 を参照してください。

- このドキュメントの 「クラスターノードの追加」 に、ノードを既存のクラスターに追加する手順が追加されました。

- 表7.1「簡単な場所の制約オプション」 の説明にあるように、新しい

resource-discoveryの場所制約オプションにより、Pacemaker が指定されたリソースのノードでリソース検出を実行すべきかどうかを指定できます。 - ドキュメント全体にわたり、記載内容の明確化を図り、若干の修正を加えました。

1.1.3. Red Hat Enterprise Linux 7.3 の新機能および変更された機能

Red Hat Enterprise Linux 7.3 ではドキュメントと機能が以下のように更新、変更されています。

- このバージョンでは、「pacemaker_remote サービス」 全体が書き直されました。

- アラートエージェントを使用して Pacemaker アラートを設定できます。アラートエージェントは、リソース設定と操作を処理するためにクラスター呼び出しのリソースエージェントと同様にクラスターが呼び出す外部プログラムです。Pacemaker アラートエージェントの説明は 「Pacemaker アラートエージェント (Red Hat Enterprise Linux 7.3 以降)」 を参照してください。

- このリリースでは新しいクォーラム管理コマンドがサポートされ、クォーラムの状態を表示し、

expected_votesパラメーターを変更できます。これらのコマンドの説明は 「クォーラム管理コマンド (Red Hat Enterprise Linux 7.3 以降)」 を参照してください。 - 「クォーラムオプションの変更 (Red Hat Enterprise Linux 7.3 以降)」 の説明に従って、pcs quorum update コマンドを使用してクラスターの一般的なクォーラムオプションを変更できるようになりました。

- クラスターのサードパーティー判別デバイスとして動作する個別のクォーラムデバイスを設定できます。この機能は主に、標準のクォーラムルールが許可するよりも多くのノード障害をクラスターで維持できるようにするために使用されます。この機能はテクニカルリビューとしてのみ提供されます。クォーラムデバイスの説明は 「クォーラムデバイス」 を参照してください。

- Red Hat Enterprise Linux 7.3 には、Booth クラスターチケットマネージャーを使用して複数のサイトにまたがる高可用性クラスターを設定する機能が提供されます。この機能はテクニカルリビューとしてのみ提供されます。Booth クラスターチケットマネージャーの説明は 14章Pacemaker を用いたマルチサイトクラスターの設定 を参照してください。

pacemaker_remoteサービスを実行している KVM ゲストノードを設定する場合、グループにゲストノードを含めることができます。これにより、ストレージデバイス、ファイルシステム、および VM をグループ化できます。KVM ゲストノードの設定に関する詳細は 「設定の概要: KVM ゲストノード」 を参照してください。

さらに、ドキュメント全体にわたり記載内容の明確化を図り、若干の修正を加えました。

1.1.4. Red Hat Enterprise Linux 7.4 の新機能および変更された機能

Red Hat Enterprise Linux 7.4 では、ドキュメントと機能が以下のように更新、変更されています。

- Red Hat Enterprise Linux 7.4 には、Booth クラスターチケットマネージャーを使用して複数のサイトにまたがる高可用性クラスターを設定する機能が完全に提供されます。Booth クラスターチケットマネージャーの説明は 14章Pacemaker を用いたマルチサイトクラスターの設定 を参照してください。

- Red Hat Enterprise Linux 7.4 は、個別のクォーラムを設定する機能に完全に対応しています。この機能は主に、標準のクォーラムルールが許可するよりも多くのノード障害をクラスターで維持できるようにするために使用されます。クォーラムデバイスの説明は 「クォーラムデバイス」 を参照してください。

- ノード名で適用した正規表現と、ノード属性とその値によってフェンシングトポロジーでノードを指定できるようになりました。フェンシングレベルの説明は、「フェンスレベルの設定」 を参照してください。

- Red Hat Enterprise Linux 7.4 は、

NodeUtilizationリソースエージェントをサポートします。これは、利用可能な CPU、ホストメモリーの可用性、およびハイパーバイザーメモリーの可用性のシステムパラメーターを検出し、これらのパラメーターを CIB に追加します。このリソースエージェントの詳細は、「NodeUtilization リソースエージェント (Red Hat Enterprise Linux 7.4 以降)」 を参照してください。 - Red Hat Enterprise Linux 7.4 では、クラスターノード add-guest コマンドおよび クラスターノード remove-guest コマンドは、cluster remote-node add および cluster remote-node remove コマンドを置き換えます。pcs cluster node add-guest コマンドはゲストノードの

authkeyをセットアップし、pcs cluster node add-remote コマンドはリモートノードのauthkeyを設定します。更新したゲストとリモートノード設定手順は、「リソースとしての仮想ドメインの設定」 を参照してください。 - Red Hat Enterprise Linux 7.4 は、

systemdresource-agents-depsターゲットに対応しています。これにより、「Pacemaker で管理されていないリソースの依存関係の起動順の設定 (Red Hat Enterprise Linux 7.4 以降)」 で説明しているように、クラスターにより管理されない依存関係を持つリソースを含むクラスターに適切な起動順序を設定できるようになります。 - マスター/スレーブクローンとしてリソースを作成するコマンドの形式は、このリリースで変更されています。マスター/スレーブクローンの作成の説明は、「多状態のリソース: 複数モードのリソース」 を参照してください。

1.1.5. Red Hat Enterprise Linux 7.5 の新機能および変更された機能

Red Hat Enterprise Linux 7.5 では、ドキュメントと機能が以下のように更新、変更されています。

- Red Hat Enterprise Linux 7.5 では、

pcs_snmp_agentデーモンを使用して、SNMP でデータについて Pacemaker クラスターを照会できます。SNMP でのクラスター照会は、「SNMP での Pacemaker クラスターを照会 (Red Hat Enterprise Linux 7.5 以降)」 を参照してください。

1.1.6. Red Hat Enterprise Linux 7.8 の新機能および変更された機能

Red Hat Enterprise Linux 7.8 では、ドキュメントと機能が以下のように更新、変更されています。

- Red Hat Enterprise Linux 7.8 以降では、ノードが正常にシャットダウンすると、ノードに接続されているリソースがノードにロックされ、シャットダウンしたノードがクラスターに再度参加するときに再び起動するまで、他の場所で起動できないように、Pacemaker を設定できます。これにより、ノードのリソースをクラスター内の他のノードにフェイルオーバーせずに、サービスの停止が許容できるメンテナンスウィンドウ中にノードの電源を切ることができます。ノードの正常なシャットダウン時に停止したままになるようにリソースを設定する方法は、「 クリーンノードのシャットダウンで停止するようにリソースを設定 (Red Hat Enterprise Linux 7.8 以降) 」 を参照してください。

1.2. Pacemaker 設定ツールのインストール

以下の yum install コマンドを使用して、Red Hat High Availability Add-On ソフトウェアパッケージと、利用可能なすべてのフェンスエージェントを High Availability チャンネルからインストールできます。

# yum install pcs pacemaker fence-agents-all

このコマンドの代わりに以下のコマンドを実行すると、Red Hat High Availability Add-On ソフトウェアパッケージと必要なフェンスエージェントのみをインストールできます。

# yum install pcs pacemaker fence-agents-model

以下のコマンドは、利用できるフェンスエージェントのリストを表示します。

# rpm -q -a | grep fence

fence-agents-rhevm-4.0.2-3.el7.x86_64

fence-agents-ilo-mp-4.0.2-3.el7.x86_64

fence-agents-ipmilan-4.0.2-3.el7.x86_64

...

lvm2-cluster および gfs2-utils パッケージは ResilientStorage チャンネルに含まれます。必要に応じて次のコマンドでインストールを行ってください。

# yum install lvm2-cluster gfs2-utils警告

Red Hat High Availability Add-On パッケージをインストールしたら、自動的に何もインストールされないように、ソフトウェア更新設定を行う必要があります。実行中のクラスターにインストールすると、予期しない動作が発生する可能性があります。

1.3. ファイアウォールでクラスターコンポーネントを許可する iptables 設定

注記

クラスターコンポーネントの理想的なファイアウォール設定は、ローカル環境によって異なります。ここでは、ノードに複数のネットワークインターフェイスがあるかどうか、またはオフホストのファイアウォールがあるかどうかを検討しないといけない場合があります。この例では、Pacemaker クラスターで通常必要となるポートを開きますが、ローカル条件に合わせて変更する必要があります。

表1.1「High Availability Add-On で有効にするポート」 では、Red Hat High Availability Add-On で有効にするポートを示し、ポートの使用目的を説明します。以下のコマンドを実行し、firewalld デーモンでこのポートをすべて有効にできます。

#firewall-cmd --permanent --add-service=high-availability#firewall-cmd --add-service=high-availability

| ポート | 必要になる場合 |

|---|---|

|

TCP 2224

|

すべてのノードで必須( pcsd Web UI で必要で、ノード間通信に必要)

任意のノードの pcs が、それ自体も含め、クラスター内のすべてのノードと通信できるように、ポート 2224 を開くことが重要です。Booth クラスターチケットマネージャーまたはクォーラムデバイスを使用する場合は、Booth Arbiter、クォーラムデバイスなどのすべての関連ホストで、ポート 2224 を開く必要があります。

|

|

TCP 3121

|

クラスターに Pacemaker リモートノードがある場合に、すべてのノードで必須です。

完全なクラスターノード上の Pacemaker の

crmd デーモンは、ポート 3121 で Pacemaker リモートノードの pacemaker_remoted デーモンに接続します。クラスター通信に別のインターフェイスを使用する場合は、そのインターフェイスでポートを開くことのみが必要になります。少なくとも、ポートは、Pacemaker リモートノードの全クラスターノードに対して開いている必要があります。ユーザーは完全なノードとリモートノード間でホストを変換する可能性があるか、またはホストのネットワークを使用してコンテナー内でリモートノードを実行する可能性があるため、すべてのノードに対してポートを開くことは役に立ちます。ノード以外のホストにポートを開く必要はありません。

|

|

TCP 5403

| corosync-qnetd でクォーラムデバイスを使用する場合は、クォーラムデバイスホストで必須です。デフォルト値は、corosync-qnetd コマンドの -p オプションで変更できます。

|

|

UDP 5404

|

corosync がマルチキャスト UDP に設定されている場合には、

corosync ノードで必須です。

|

|

UDP 5405

|

すべての corosync ノードで必須(

corosyncで必要)

|

|

TCP 21064

|

DLM に必要なリソース(

clvm や GFS2など)がクラスターに含まれる場合に、すべてのノードで必須です。

|

|

TCP 9929、UDP 9929

|

Booth チケットマネージャーを使用してマルチサイトクラスターを確立するときに、すべてのクラスターノード、および同じノードのいずれかからの接続に対して Booth arbitrator ノードで開いている必要があります。

|

1.4. クラスターと Pacemaker の設定ファイル

Red Hat High Availability アドオンの設定ファイルは、

corosync.conf および cib.xml です。

corosync.conf ファイルは、Pacemaker が構築されているクラスターマネージャーである corosync が使用するクラスターパラメーターを提供します。一般的に、corosync.conf を直接編集するのではなく、pcs または pcsd インターフェイスを使用します。ただし、このファイルを直接編集する必要のある状況も考えられます。corosync.conf ファイルの編集は、Editing the corosync.conf file in Red Hat Enterprise Linux 7 を参照してください。

cib.xml ファイルは、クラスターの設定、およびクラスターの全リソースの現在の状態を表す XML ファイルです。このファイルは Pacemaker のクラスター情報ベース (CIB) により使用されます。CIB の内容はクラスター全体で自動的に同期されます。cib.xml ファイルは直接編集せず、代わりに pcs または pcsd インターフェイスを使用してください。

1.5. クラスター設定の注意事項

Red Hat High Availability Add-On クラスターの設定時、以下の注意事項を考慮する必要があります。

- RHEL 7.7 以降、Red Hat はノード数が 32 個を超えるクラスターデプロイメントをサポートしていません。ただし、

pacemaker_remoteサービスを実行しているリモートノードでは、この制限を超えた拡張が可能です。pacemaker_remoteサービスの説明は 「pacemaker_remote サービス」 を参照してください。 - DHCP (Dynamic Host Configuration Protocol)を使用した

corosyncデーモンで使用されるネットワークインターフェイス上の IP アドレスの取得はサポートされていません。アドレスの更新中、DHCP クライアントは割り当てられたインターフェイスに対して定期的に IP アドレスを削除および再追加することができます。これにより、corosyncが接続障害を検出し、クラスターの他のノードからのフェンシングアクティビティーがハートビート接続にcorosyncを使用します。

1.6. Red Hat Enterprise Linux High Availability クラスターの更新

RHEL High Availability Add-On および Resilient Storage Add-On を設定するパッケージを、個別または一括で更新するには、以下に示す一般的な方法のいずれかを使用できます。

- ローリング更新 - サービスからノードを、一度に 1 つずつ削除し、そのソフトウェアを更新してから、そのノードをクラスターに戻します。これにより、各ノードの更新中も、クラスターがサービスの提供とリソースの管理を継続できます。

- クラスター全体の更新 - クラスター全体を停止し、更新をすべてのノードに適用してから、クラスターのバックアップを開始します。

警告

Red Hat Enterprise LInux の High Availability クラスターおよび Resilient Storage クラスターのソフトウェア更新手順を実行する場合は、更新を開始する前に、更新を行うノードがクラスターのアクティブなメンバーではないことを確認する必要があります。

これらの各方法の詳細な説明および更新手順はRecommended Practices for Applying Software Updates to a RHEL High Availability or Resilient Storage Clusterを参照してください。

1.7. RHEL クラスターでの VM のライブ移行についての問題

仮想化クラスターメンバーとの RHEL 高可用性クラスターのサポートポリシーの説明は、Support Policies for RHEL High Availability Clusters - General Conditions with Virtualized Cluster Members を参照してください。前述のように、Red Hat は、ハイパーバイザーまたはホスト全体のアクティブなクラスターノードのライブマイグレーションはサポート対象外です。ライブマイグレーションを実行する必要がある場合は、まず仮想マシンでクラスターサービスを停止して、クラスターからノードを削除し、移行後にクラスターを起動する必要があります。

以下の手順では、クラスターから仮想マシンを削除し、仮想マシンを移行し、クラスターに仮想マシンを復元する手順の概要を説明します。

注記

この手順を実行する前に、クラスターノードを削除するクラスタークォーラム (定足数) への影響を考慮してください。3 つのノードクラスターがあり、1 つのノードを削除する場合、クラスターが耐えられるのは、あと 1 つのノードエラーのみです。3 つのノードクラスターの 1 つがすでにダウンしている場合は、2 つ目のノードを削除すると、クォーラムが失われます。

- 移行する仮想マシンで実行しているリソースやソフトウェアの停止または移動を行う前に準備を行う必要がある場合は、以下の手順を実行します。

- 管理リソースを VM から移動します。リソースの割り当てに関する特定の要件や条件がある場合は、正しいノードにリソースを配置するための新しい場所の制約を作成することを考慮してください。

- VM をスタンバイモードにして、サービスで考慮されていないことや、残りのリソースが別の場所に再配置され、停止されるようにします。

#

pcs cluster standby VM - 仮想マシンで以下のコマンドを実行して、仮想マシン上のクラスターソフトウェアを停止します。

#

pcs cluster stop - 仮想マシンのライブマイグレーションを実行します。

- 仮想マシンでクラスターサービスを起動します。

#

pcs cluster start - VM をスタンバイモードから解除します。

#

pcs cluster unstandby VM - VM をスタンバイモードにする前に一時的な場所の制約を作成した場合、これらの制約を調整または削除して、リソースが通常の優先場所に戻れるようにします。

第2章 pcsd Web UI

本章では、pcsd Web UI を使用した Red Hat High Availability クラスターの設定の概要を説明します。

2.1. pcsd Web UI の設定

pcsd Web UI を使用してクラスターを設定するようにシステムを設定するには、以下の手順に従います。

- 「Pacemaker 設定ツールのインストール」 の説明に従って Pacemaker 設定ツールをインストールします。

- クラスターの一部である各ノードで、passwd コマンドを使用して、各ノードで同じパスワードを使用してユーザー

haclusterのパスワードを設定します。 - 各ノードで pcsd デーモンを開始して有効にします。

#

systemctl start pcsd.service#systemctl enable pcsd.service - クラスターの 1 つのノードで、以下のコマンドを使用してクラスターを設定するノードを認証します。このコマンドを実行すると、

UsernameとPasswordの入力を求められます。Usernameにはhaclusterを指定します。#

pcs cluster auth node1 node2 ... nodeN - いずれかのシステムで、次の URL をブラウザーで開き、承認したノードの 1 つを指定します(

httpsプロトコルを使用することに注意してください)。これにより、pcsd Web UI のログイン画面が表示されます。https://nodename:2224

図2.1 クラスターの管理ページ

[D]

2.2. pcsd Web UI を用いたクラスターの作成

ページでは、新規クラスターの作成、既存のクラスターの Web UI への追加、または Web UI からのクラスターの削除を行うことができます。

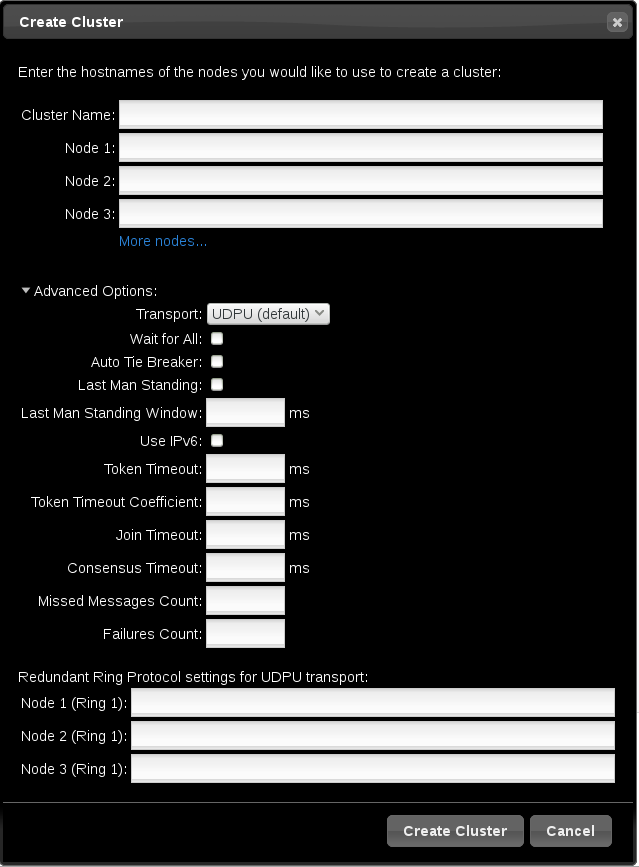

- クラスターを作成するには、Create New をクリックし、作成するクラスターとクラスターを設定するノードの名前を入力します。また、この画面では 「高度なクラスター設定オプション」 に記載されているクラスター通信のトランスポートメカニズムなどの高度なクラスターオプションを設定することもできます。クラスター情報を入力したら、 をクリックします。

- 既存のクラスターを Web UI に追加するには、Add Existing をクリックし、Web UI で管理するクラスターのノードのホスト名または IP アドレスを入力します。

クラスターを作成または追加すると、 ページにクラスター名が表示されます。クラスターを選択すると、クラスターに関する情報が表示されます。

注記

pcsd Web UI を使用してクラスターを設定する場合、多くのオプションを説明するテキストの上にマウスを移動すると、このオプションの詳細な説明が

ツールチップ 表示として表示できます。

2.2.1. 高度なクラスター設定オプション

クラスターの作成時、図2.2「クラスターページの作成」 に示されるように をクリックすると追加のクラスターオプションを設定できます。表示されるオプションのテキスト上にマウスを移動すると、そのオプションの情報を確認できます。

各ノードのインターフェイスを指定すると、クラスターに冗長リングプロトコル (Redundant Ring Protocol) を設定できます。クラスターのトランスポートメカニズムとして ではなく を選択した場合、Redundant Ring Protocol 設定が表示されます。

図2.2 クラスターページの作成

[D]

2.2.2. クラスター管理パーミッションの設定

ユーザーに付与できるクラスターパーミッションには、以下の 2 つのセットがあります。

- Web UI を使用してクラスターを管理するためのパーミッション。ネットワーク経由でノードに接続する pcs コマンドを実行するパーミッションも付与されます。本セクションでは、Web UI でこのパーミッションを設定する方法を説明します。

- ACL を使用し、クラスター設定への読み取り専用アクセスまたは読み書きアクセスをローカルユーザーに許可するパーミッション。Web UI で ACL を設定する方法は、「ACL の設定」 を参照してください。

ユーザーのパーミッションの詳細は、「ユーザーのパーミッション設定」 を参照してください。

グループ

haclient にユーザーを追加することで、ユーザー hacluster 以外の特定のユーザーにパーミッションを付与し、Web UI でクラスターを管理し、ネットワーク経由でノードに接続する pcs コマンドを実行できます。次に、 ページの タブをクリックし、表示された画面でパーミッションを設定すると、グループ haclient の個別のメンバーにパーミッションセットを設定できます。この画面では、グループのパーミッションを設定することもできます。

以下のパーミッションを付与できます。

- 読み取りパーミッション (クラスター設定の表示)

- 書き込みパーミッション (パーミッションおよび ACL を除くクラスター設定の変更)

- 付与パーミッション (クラスターパーミッションおよび ACL の変更)

- フルパーミッション (ノードの追加や削除などのクラスターへの無制限アクセス、およびキーや証明書へのアクセス)

2.3. クラスターコンポーネントの設定

クラスターのコンポーネントおよび属性を設定するには、Manage Clusters 画面に表示されるクラスターの名前をクリックします。これにより、「クラスターノード」 に示されるように、Nodes ページが表示されます。図2.3「クラスターコンポーネントのメニュー」 の説明どおり、このページの上部には以下のエントリーが含まれるメニューが表示されます。

- (で説明されている) 「クラスターノード」

- (を参照) 「クラスターリソース」

- (を参照) 「フェンスデバイス」

- (を参照) 「ACL の設定」

- (クラスタープロパティー)を参照してください。 「クラスターのプロパティー」

図2.3 クラスターコンポーネントのメニュー

[D]

2.3.1. クラスターノード

クラスター管理ページの上部にあるメニューから ノード オプションを選択すると、現在設定されているノードと、現在選択されているノードのステータス(ノード上で実行されているリソースやリソースの場所の設定など)が表示されます。

このページでノードを追加または削除することができ、ノードを起動、停止、および再起動することができます。スタンバイモードの詳細は、「スタンバイモード」 を参照してください。

また、

Configure Fencing を選択することで、「フェンスデバイス」 で説明されているように、このページで直接フェンスデバイスを設定することもできます。

2.3.2. クラスターリソース

クラスター管理ページの上部にあるメニューから Resources オプションを選択すると、クラスターに現在設定されているリソースがリソースグループに応じて表示されます。グループまたはリソースを選択すると、そのグループまたはリソースの属性が表示されます。

この画面では、リソースの追加または削除、既存リソースの設定の編集、およびリソースグループの作成を行うことができます。

新しいリソースをクラスターに追加するには、Add をクリックします。Add Resource 画面が表示されます。ドロップダウン タイプ メニューからリソースタイプを選択すると、そのリソースに指定する必要がある引数がメニューに表示されます。Optional Arguments をクリックすると、定義するリソースに指定できる任意の引数を表示できます。作成するリソースのパラメーターを入力したら、 をクリックします。

リソースの引数を設定する際に、引数の簡単な説明がメニューに表示されます。カーソルをフィールドに移動すると、その引数のヘルプが表示されます。

リソースは、クローンされたリソースまたはマスター/スレーブリソースして定義できます。これらのリソースタイプの詳細は、9章高度な設定 を参照してください。

少なくとも 1 つのリソースを作成したら、リソースグループを作成できます。リソースグループの詳細は 「リソースグループ」 を参照してください。

リソースグループを作成するには、Resources 画面でグループの一部であるリソースを選択し、Create Group をクリックします。Create Group 画面が表示されます。グループ名を入力し、 をクリックします。これにより、リソースのグループ名を表示する リソース 画面に戻ります。リソースグループを作成したら、追加のリソースを作成または変更する際に、グループ名をリソースパラメーターとして指定できます。

2.3.3. フェンスデバイス

クラスター管理ページの上部にあるメニューから Fence Devices オプションを選択すると、Fence Devices 画面が表示され、現在設定されているフェンスデバイスが表示されます。

新しいフェンスデバイスをクラスターに追加するには、Add をクリックします。フェンスデバイスの追加 画面が表示されます。ドロップダウンメニューからフェンスデバイスのタイプを選択すると、そのフェンスデバイスに指定する必要がある引数がメニューに表示されます。Optional Arguments をクリックすると、定義するフェンスデバイスに指定できる追加の引数を表示できます。新しいフェンスデバイスのパラメーターを入力したら、 をクリックします。

Pacemaker を用いたフェンスデバイスの設定の詳細は 5章フェンス機能: STONITH の設定 を参照してください。

2.3.4. ACL の設定

クラスター管理ページの上部にあるメニューから

ACL オプションを選択すると、ローカルユーザーのパーミッションを設定できる画面が表示され、アクセス制御リスト(ACL)を使用してクラスター設定への読み取り専用または読み書きアクセスが可能になります。

ACL パーミッションを割り当てるには、ロールを作成し、そのロールのアクセスパーミッションを定義します。各ロールには、XPath クエリーまたは特定要素の ID のいずれかにパーミッション (読み取り/書き込み/拒否) をいくつでも適用できます。ロールを定義したら、既存のユーザーまたはグループに割り当てることができます。

2.3.5. クラスターのプロパティー

クラスター管理ページの上部にあるメニューから

Cluster Properties オプションを選択するとクラスタープロパティーが表示され、このプロパティーをデフォルト値から変更できます。Pacemaker クラスタープロパティーの詳細は 12章Pacemaker クラスターのプロパティー を参照してください。

2.4. 高可用性 pcsd Web UI の設定

pcsd Web UI を使用すると、クラスターのノードのいずれかに接続して、クラスター管理ページを表示できます。接続先のノードがダウンするか、使用できなくなった場合は、クラスターの別のノードを指定する URL でブラウザーを開くと、クラスターに再接続できます。ただし、pcsd Web UI 自体を高可用性向けに設定することもできます。この場合、新しい URL を入力することなく継続してクラスターを管理できます。

高可用性に

pcsd Web UI を設定するには、以下の手順を実行します。

/etc/sysconfig/pcsd設定ファイルでPCSD_SSL_CERT_SYNC_ENABLEDがtrueに設定されていることを確認します。これは、RHEL 7 のデフォルト値です。証明書の同期を有効にすると、pcsdはクラスター設定とノードの add コマンドのpcsd証明書を同期します。pcsdWeb UI への接続に使用するフローティング IP アドレスであるIPaddr2クラスターリソースを作成します。物理ノードに関連付けられている IP アドレスは使用できません。IPaddr2リソースの NIC デバイスが指定されていない場合は、そのノードに静的に割り当てられている IP アドレスの 1 つと同じネットワークにフローティング IP が存在している必要があります。存在していないと、Floating IP アドレスを割り当てる NIC デバイスが適切に検出されません。- pcsd で使用するカスタム SSL 証明書を作成し、

pcsd- カスタムの SSL 証明書を作成するには、ワイルドカード証明書を使用するか、SAN (Subject Alternative Name: サブジェクトの別名) 証明書の延長を使用できます。Red Hat 証明書システムに関する詳細は、Red Hat Certificate System Administration Guideを参照してください。

- pcs pcsd certkey コマンドを使用して

pcsdのカスタム証明書をインストールします。 - pcs

pcsdsync-certificates コマンドを使用して、pcsd 証明書をクラスター内のすべてのノードに同期します。

- クラスターリソースとして設定したフローティング IP アドレスを使用して、

pcsdWeb UI に接続します。

注記

高可用性向けに

pcsd Web UI を設定しても、接続先のノードがダウンすると、再度ログインするよう求められます。

第3章 pcs コマンドラインインターフェイス

pcs コマンドラインインターフェイスは、

corosync.conf ファイルおよび cib.xml ファイルにインターフェイスを提供することで、corosync および Pacemaker を制御し、設定します。

pcs コマンドの一般的な形式は以下のとおりです。

pcs [-f file] [-h] [commands]...

3.1. pcs コマンド

pcs コマンドは以下のとおりです。

clusterクラスターオプションおよびノードの設定を行います。pcs cluster コマンドの詳細は 4章クラスターの作成と管理 を参照してください。resourcestonithPacemaker との使用に備えてフェンスデバイスを設定します。pcs stonith コマンドの詳細は、5章フェンス機能: STONITH の設定 を参照してください。constraintリソースの制約を管理します。pcs constraint コマンドの詳細は、7章リソースの制約 を参照してください。プロパティーPacemaker のプロパティーを設定します。pcs property コマンドでプロパティーを設定する方法については 12章Pacemaker クラスターのプロパティー を参照してください。status現在のクラスターとリソースの状態を表示します。pcs status コマンドの詳細は 「状態の表示」 を参照してください。configユーザーが理解できる形式でクラスターの全設定を表示します。pcs config コマンドの詳細は 「全クラスター設定の表示」 を参照してください。

3.2. pcs の使用に関するヘルプ表示

pcs の

-h オプションを使用すると pcs コマンドのパラメーターとその説明が表示されます。たとえば、以下のコマンドは pcs resource コマンドのパラメーターを表示します。出力の一部だけが表示されます。

# pcs resource -h

Usage: pcs resource [commands]...

Manage pacemaker resources

Commands:

show [resource id] [--all]

Show all currently configured resources or if a resource is specified

show the options for the configured resource. If --all is specified

resource options will be displayed

start <resource id>

Start resource specified by resource_id

...

3.3. raw クラスター設定の表示

クラスター設定ファイルは直接編集する必要はありませんが、pcs cluster cib コマンドを使用すると未加工クラスター 設定を表示できます。

「設定の変更をファイルに保存」 に記載されているように、pcs cluster cib filenameコマンドを使用すると raw クラスター 設定を指定のファイルに保存することができます。

3.4. 設定の変更をファイルに保存

pcs コマンドを使用する場合は、

-f オプションを使用して、アクティブな CIB に影響を与えずに、ファイルに設定変更を保存できます。

クラスターを事前に設定していて、アクティブな CIB が存在する場合は、以下のコマンドを実行して、未編集の xml ファイルを保存します。

pcs cluster cib filename

たとえば、以下のコマンドは CIB の未加工の xml を

testfile という名前のファイルに保存します。

# pcs cluster cib testfile

以下のコマンドは、

testfile ファイルにリソースを作成しますが、リソースを現在実行中のクラスター設定には追加しません。

# pcs -f testfile resource create VirtualIP ocf:heartbeat:IPaddr2 ip=192.168.0.120 cidr_netmask=24 op monitor interval=30s

次のコマンドを使用して、

testfile の現在のコンテンツを CIB にプッシュできます。

# pcs cluster cib-push testfile3.5. 状態の表示

次のコマンドで、クラスターおよびクラスターリソースのステータスを表示します。

pcs status commands

commands パラメーターを指定しないとクラスターおよびリソースの全情報が表示されます。

resources、groups、cluster、nodes、または pcsd を指定すると、特定のクラスター コンポーネントのみの状態を表示します。

3.6. 全クラスター設定の表示

現在のクラスター設定をすべて表示する場合は、次のコマンドを実行します。

pcs config

3.7. 現在の pcs バージョンの表示

以下のコマンドは、実行中の pcs の現行バージョンを表示します。

pcs --version

3.8. クラスター設定のバックアップおよび復元

Red Hat Enterprise Linux 7.1 リリース以降では、以下のコマンドを使用してクラスター設定を tarball にバックアップできます。ファイル名を指定しないと、標準出力が使用されます。

pcs config backup filename

以下のコマンドを使用して、バックアップからすべてのクラスターノードのクラスター設定ファイルを復元します。

--local オプションを指定すると、このコマンドを実行するノードでのみクラスター設定ファイルが復元されます。ファイル名を指定しないと、標準入力が使用されます。

pcs config restore [--local] [filename]

第4章 クラスターの作成と管理

本章ではクラスターの作成、クラスターコンポーネントの管理、クラスターの状態表示など Pacemaker で行うクラスターの基本的な管理について見ていきます。

4.1. クラスターの作成

クラスターを作成するため次のステップを行って行きます。

- クラスターの各ノードで pcsd を開始します。

- クラスターを設定するノードを認証します。

- クラスターノードの設定と同期を行います。

- クラスターノードでクラスターサービスを起動します。

次のセクションでは、上記の手順で使用するコマンドについて詳しく見ていきます。

4.1.1. pcsd デーモンの開始

以下のコマンドは

pcsd サービスを起動し、システムの起動時に pcsd を有効にします。これらのコマンドはクラスターの各ノードで実行する必要があります。

#systemctl start pcsd.service#systemctl enable pcsd.service

4.1.2. クラスターノードの認証

次のコマンドは、クラスター内のノード上の

pcs デーモンに対して pcs を認証します。

- すべてのノードで

pcs管理者のユーザー名はhaclusterである必要があります。haclusterユーザーのパスワードは、各ノードで同じにすることが推奨されます。 usernameまたはpasswordを指定しないと、コマンドの実行時にノードごとにこれらのパラメーターの入力を求められます。- ノードを指定しないと、以前に

pcscluster setup コマンドで指定したノードの pcs が認証されます。

pcs cluster auth [node] [...] [-u username] [-p password]

たとえば、以下のコマンドは

z1.example.com と z2.example.com の両方で設定されるクラスター内の両方のノードに対して、z1.example.com のユーザー hacluster を認証します。このコマンドは、クラスターノードのユーザー hacluster のパスワードを要求します。

root@z1 ~]# pcs cluster auth z1.example.com z2.example.com

Username: hacluster

Password:

z1.example.com: Authorized

z2.example.com: Authorized

承認トークンは、~/

.pcs/tokens ファイル(または /var/lib/pcsd/tokens )に保存されます。

4.1.3. クラスターノードの設定と起動

次のコマンドでクラスター設定ファイルの設定、指定ノードに対する設定の同期を行います。

--startオプションを使用すると指定ノードでクラスターサービスが起動します。必要に応じて、別の pcs cluster start コマンドを使用してクラスターサービスを起動することもできます。pcs cluster setup --start コマンドを使用してクラスターを作成する場合、または pcs cluster start コマンドでクラスターサービスを開始する場合、クラスターが稼働するまでにわずかな遅延が生じる可能性があります。クラスターとその設定で後続のアクションを実行する前に、pcs cluster status コマンドを使用してクラスターが稼働していることを確認することが推奨されます。--localオプションを指定すると、ローカルノードでのみ変更が実行されます。

pcs cluster setup [--start] [--local] --name cluster_ name node1 [node2] [...]

次のコマンドは指定ノード (複数指定可) でクラスターサービスを起動します。

--allオプションを使用するとすべてのノードでクラスターサービスを起動します。- ノードを指定しないとクラスターサービスはローカルのノードでしか起動されません。

pcs cluster start [--all] [node] [...]

4.2. クラスターのタイムアウト値の設定

pcs cluster setup コマンドを使用してクラスターを作成する場合、クラスターのタイムアウト値はほとんどのクラスター設定に適したデフォルト値に設定されます。システムに他のタイムアウト値が必要な場合は、に記載されている pcs cluster setup オプションを使用してデフォルト値を変更できます。 表4.1「タイムアウトオプション」

| オプション | 説明 |

|---|---|

--token timeout | トークンを受信しなかった後にトークンの損失が宣言されるまでの時間をミリ秒単位で設定します (デフォルトは 1000 ms です)。 |

--join timeout | join メッセージの待ち時間をミリ秒単位で設定します (デフォルトは 50 ms です)。 |

--consensus timeout | 新しいメンバーシップの設定を開始する前に合意が得られるまでの待ち時間をミリ秒単位で設定します (デフォルトは 1200 ms です)。 |

--miss_count_const count | 再送信が行われる前に、トークンの受信時に再送信のメッセージがチェックされる最大回数を設定します。デフォルトは 5 (5 つのメッセージ) です。 |

--fail_recv_const failures | 新しい設定の設定前に、受信しなければならないメッセージが発生する可能性がある場合、メッセージを受信せずにトークンをローテーションする回数を指定します (デフォルトの失敗数は 2500 です)。 |

たとえば、以下のコマンドは

new_cluster クラスターを作成し、トークンのタイムアウト値を 10000 ミリ秒(10 秒)に設定し、join タイムアウト値を 100 ミリ秒に設定します。

# pcs cluster setup --name new_cluster nodeA nodeB --token 10000 --join 1004.3. 冗長リングプロトコル (RRP) の設定

注記

Red Hat は、 Support Policies for RHEL High Availability Clusters - Cluster Interconnect Network Interfaces の Redundant Ring Protocol (RRP) の項で説明している条件に依存する、クラスターでの冗長リングプロトコルに対応しています。

pcs cluster setup コマンドを使用してクラスターを作成する場合、各ノードに両方のインターフェイスを指定することで冗長リングプロトコルを使用してクラスターを設定できます。デフォルトの udpu トランスポートを使用する場合にクラスターノードを指定するには、リング 0 アドレス、,、リング 1 アドレスの順に指定します。

たとえば、以下のコマンドはノード A とノード B の 2 つのノードを持つ

my_rrp_clusterM という名前のクラスターを設定します。ノード A には nodeA -0 と nodeA- 1 の 2 つのインターフェイスがあります。ノード B には、nodeB -0 と nodeB- 1 の 2 つのインターフェイスがあります。RRP を使用してこれらのノードをクラスターとして設定するには、以下のコマンドを実行します。

# pcs cluster setup --name my_rrp_cluster nodeA-0,nodeA-1 nodeB-0,nodeB-1 udp トランスポートを使用するクラスターで RRP を設定する方法は、pcs cluster setup コマンドのヘルプ画面を参照してください。

4.4. クラスターノードの管理

次のセクションではクラスターサービスの起動や停止、クラスターノードの追加や削除などクラスターノードの管理で使用するコマンドについて説明します。

4.4.1. クラスターサービスの停止

次のコマンドで、指定ノード (複数指定可) のクラスターサービスを停止します。pcs cluster start と同様に、

--all オプションを指定すると全ノードのクラスターサービスが停止され、ノードを指定しないとローカルノードでのみクラスターサービスが停止します。

pcs cluster stop [--all] [node] [...]

次のコマンドで、ローカルノードでクラスターサービスを強制的に停止できます。このコマンドは、kill -9 コマンドを実行します。

pcs cluster kill

4.4.2. クラスターサービスの有効化および無効化

指定ノード (複数指定可) の起動時にクラスターサービスが実行されるよう設定する場合は次のコマンドを使用します。

--allオプションを使用すると、全ノードでクラスターサービスが有効になります。- ノードを指定しないと、ローカルノードでのみクラスターサービスが有効になります。

pcs cluster enable [--all] [node] [...]

指定した 1 つまたは複数のノードの起動時に、クラスターサービスが実行されないよう設定する場合は、次のコマンドを使用します。

--allオプションを使用すると、全ノードのクラスターサービスが無効になります。- ノードを指定しないと、ローカルノードでのみクラスターサービスが無効になります。

pcs cluster disable [--all] [node] [...]

4.4.3. クラスターノードの追加

注記

運用保守期間中に、既存のクラスターにノードを追加することが強く推奨されます。これにより、新しいノードとそのフェンシング設定に対して、適切なリソースとデプロイメントのテストを実行できます。

既存クラスターに新しいノードを追加する場合は、以下の手順に従ってください。この例では、既存のクラスターノードは

clusternode-01.example.com、clusternode-02.example.com、および clusternode-03.example.com です。新しいノードは newnode.example.com になります。

クラスターに追加する新しいノードで、以下の作業を行います。

- クラスターパッケージをインストールします。クラスターが SBD、Booth チケットマネージャー、またはクォーラムデバイスを使用する場合、新しいノードにそれぞれのパッケージ(

sbd、ブートサイト、)も手動でインストールする必要があります。corosync-qdevice[root@newnode ~]#

yum install -y pcs fence-agents-all - firewalld デーモンを実行している場合は、以下のコマンドを実行して Red Hat High Availability Add-On で必要なポートを有効にします。

#

firewall-cmd --permanent --add-service=high-availability#firewall-cmd --add-service=high-availability - ユーザー ID

haclusterのパスワードを設定します。クラスターの各ノードで、同じパスワードを使用することが推奨されます。[root@newnode ~]#

passwd haclusterChanging password for user hacluster. New password: Retype new password: passwd: all authentication tokens updated successfully. - 以下のコマンドを実行して

pcsdサービスを開始し、システムの起動時にpcsdを有効にします。#

systemctl start pcsd.service#systemctl enable pcsd.service

既存クラスターのノードの 1 つで、以下の作業を行います。

- 新しいクラスターノードで

haclusterユーザーを認証します。[root@clusternode-01 ~]#

pcs cluster auth newnode.example.comUsername: hacluster Password: newnode.example.com: Authorized - 新しいノードを既存のクラスターに追加します。また、このコマンドは

corosync.confクラスター設定ファイルをクラスター内のすべてのノード(追加する新しいノードを含む)に同期します。[root@clusternode-01 ~]#

pcs cluster node add newnode.example.com

クラスターに追加する新しいノードで、以下の作業を行います。

- 新しいノードで、クラスターサービスを開始して有効にします。

[root@newnode ~]#

pcs cluster startStarting Cluster... [root@newnode ~]#pcs cluster enable - 新しいクラスターノードに対して、フェンシングデバイスを設定してテストします。フェンスデバイスの設定は 5章フェンス機能: STONITH の設定 を参照してください。

4.4.4. クラスターノードの削除

次のコマンドは、指定したノードをシャットダウンし、クラスター内の他のすべてのノードで、クラスター設定ファイル

corosync.conf からそのノードを削除します。クラスターに関するすべての情報をクラスターノード全体で削除し、クラスターを完全に破棄する方法については、「クラスター設定の削除」 を参照してください。

pcs cluster node remove node

4.4.5. スタンバイモード

以下のコマンドは、指定ノードをスタンバイモードにします。指定ノードはリソースのホストが行えなくなります。ノードで現在アクティブなリソースは、すべて別のノードに移行されます。

--all を指定すると、このコマンドはすべてのノードをスタンバイモードにします。

リソースのパッケージを更新する場合にこのコマンドを使用します。また、設定をテストして、ノードを実際にシャットダウンせずに復元のシュミレーションを行う場合にも、このコマンドを使用できます。

pcs cluster standby node | --all

次のコマンドは、指定したノードをスタンバイモードから外します。このコマンドを実行すると、指定ノードはリソースをホストできるようになります。

--all を指定すると、このコマンドはすべてのノードをスタンバイモードから外します。

pcs cluster unstandby node | --all

pcs cluster standby コマンドを実行すると、指定したノードでのリソースが実行されないことに注意してください。pcs cluster unstandby コマンドを実行すると、指定したノードでリソースを実行できます。このコマンドを実行しても、リソースが必ずしも指定のノードに戻る訳ではありません。その時点でリソースが実行できる場所は、リソースを最初に設定した方法によって異なります。リソース制約の詳細は 7章リソースの制約 を参照してください。

4.5. ユーザーのパーミッション設定

ユーザー

hacluster 以外の特定のユーザーに、クラスターを管理するパーミッションを付与できます。個々のユーザーに付与できるパーミッションには、以下の 2 つのセットがあります。

- 「ネットワーク上でのノードアクセスのパーミッション設定」 で説明しているように、個々のユーザーが Web UI からクラスターを管理でき、ネットワークからノードに接続できる pcs コマンドを実行可能なパーミッション。ネットワーク経由でノードに接続するコマンドには、クラスターを設定するコマンド、またはクラスターからノードを追加または削除するためのコマンドが含まれます。

- 「ACL を使用したローカルパーミッションの設定」 で説明しているように、クラスター設定への読み込み専用または書き込み専用アクセスをローカルユーザーに許可するパーミッション。ネットワーク経由で接続する必要のないコマンドには、リソースの作成や制約の設定など、クラスター設定を編集するコマンドが含まれます。

両方のパーミッションセットが割り当てられている状況では、ネットワーク経由で接続するコマンドのパーミッションが最初に適用され、次にローカルノードのクラスター設定を編集するパーミッションが適用されます。ほとんどの pcs コマンドは、ネットワークアクセスを必要とせず、ネットワークパーミッションが適用されません。

4.5.1. ネットワーク上でのノードアクセスのパーミッション設定

Web UI でクラスターを管理し、ネットワークからノードに接続する pcs コマンドを実行するパーミッションを特定のユーザーに付与するには、それらのユーザーをグループ

haclient に追加します。「クラスター管理パーミッションの設定」 で説明しているように、Web UI を使用することで、これらのユーザーにパーミッションを付与することができます。

4.5.2. ACL を使用したローカルパーミッションの設定

Red Hat Enterprise Linux 7.1 より、pcs acl コマンドを使用してローカルユーザーのパーミッションを設定し、アクセス制御リスト(ACL)を使用してクラスター設定への読み取り専用アクセスまたは読み書きアクセスを許可できます。また、「ACL の設定」 で説明しているように、pcsd Web UI を使用して ACL を設定することも可能です。デフォルトでは、root ユーザーと、

haclient グループのメンバーユーザーは、クラスター設定への完全なローカル読み取り/書き込みアクセスを持ちます。

ローカルユーザーのパーミッションを設定するには、以下の 2 つの手順を実行します。

- pcs acl role create... コマンドを実行して、その ロール のパーミッションを定義するロールを作成します。

- pcs acl user create コマンドで作成したロールをユーザーに割り当てます。

以下の例では、

rouser という名前のローカルユーザーに、クラスター設定に対する読み取り専用アクセスを提供します。

- この手順では、

rouserユーザーがローカルシステムに存在し、rouserユーザーがhaclientグループのメンバーである必要があります。#

adduser rouser#usermod -a -G haclient rouser enable-aclクラスタープロパティーで Pacemaker ACL を有効にします。#

pcs property set enable-acl=true --force- cib に対して読み取り専用権限を持つ

read-onlyという名前のロールを作成します。#

pcs acl role create read-only description="Read access to cluster" read xpath /cib - pcs ACL システムで

rouserユーザーを作成し、そのユーザーに読み取り専用ロールを割り当てます。#

pcs acl user create rouser read-only - 現在の ACL を表示します。

#

pcs aclUser: rouser Roles: read-only Role: read-only Description: Read access to cluster Permission: read xpath /cib (read-only-read)

以下の例では、

wuser という名前のローカルユーザーにクラスター設定の書き込みアクセスを提供します。

- この手順では、

wuserユーザーがローカルシステムに存在し、wuserユーザーがhaclientグループのメンバーである必要があります。#

adduser wuser#usermod -a -G haclient wuser enable-aclクラスタープロパティーで Pacemaker ACL を有効にします。#

pcs property set enable-acl=true --force- cib に対して書き込みパーミッションを持つ

write-accessという名前のロールを作成します。#

pcs acl role create write-access description="Full access" write xpath /cib - pcs ACL システムで

wuserユーザーを作成し、そのユーザーにwrite-accessロールを割り当てます。#

pcs acl user create wuser write-access - 現在の ACL を表示します。

#

pcs aclUser: rouser Roles: read-only User: wuser Roles: write-access Role: read-only Description: Read access to cluster Permission: read xpath /cib (read-only-read) Role: write-access Description: Full Access Permission: write xpath /cib (write-access-write)

クラスター ACL の詳細は、pcs acl コマンドのヘルプ画面を参照してください。

4.6. クラスター設定の削除

クラスター設定ファイルをすべて削除し全クラスターサービスを停止、クラスターを永久的に破棄する場合は次のコマンドを使用します。

警告

作成したクラスター設定をすべて永久に削除します。クラスターを破棄する前に、pcs cluster stop を実行することが推奨されます。

pcs cluster destroy

4.7. クラスターの状態表示

次のコマンドで現在のクラスターとクラスターリソースの状態を表示します。

pcs status

次のコマンドを使用すると現在のクラスターの状態に関するサブセット情報を表示させることができます。

このコマンドはクラスターの状態を表示しますが、クラスターリソースの状態は表示しません。

pcs cluster status

クラスターリソースの状態は次のコマンドで表示させます。

pcs status resources

4.8. クラスターメンテナンス

クラスターのノードでメンテナンスを実行するには、そのクラスターで実行しているリソースおよびサービスを停止するか、または移行する必要がある場合があります。または、サービスを変更しない状態で、クラスターソフトウェアの停止が必要になる場合があります。Pacemaker は、システムメンテナンスを実行するための様々な方法を提供します。

- クラスターの別のノードでサービスが継続的に実行している状態で、クラスター内のノードを停止する必要がある場合は、そのクラスターノードをスタンバイモードにすることができます。スタンバイノードのノードは、リソースをホストすることができなくなります。ノードで現在アクティブなリソースは、別のノードに移行するか、(他のノードがそのリソースを実行できない場合は) 停止します。スタンバイモードの詳細は、「スタンバイモード」 を参照してください。

- リソースを停止せずに、現在実行しているノードから個別のリソースを移行する必要がある場合は、pcs resource move コマンドを使用してリソースを別のノードに移行できます。pcs resource move コマンドの詳細は、「リソースを手作業で移動する」 を参照してください。pcs resource move コマンドを実行すると、現在実行しているノードでリソースが実行されないように、制約がリソースに追加されます。リソースを戻す準備ができたら、pcs resource clear または pcs constraint delete コマンドを実行して制約を削除できます。ただし、このコマンドを実行しても、リソースが必ずしも元のノードに戻る訳ではありません。その時点でリソースが実行できる場所は、リソースを最初に設定した方法によって異なるためです。「現在のノードからリソースを移動」 で説明しているように、pcs resource relocate run コマンドを使用すると、リソースを指定のノードに移動できます。

- 実行中のリソースを完全に停止し、クラスターが再び起動しないようにする必要がある場合は、pcs resource disable コマンドを使用できます。pcs resource disable コマンドの詳細は、「クラスターリソースの有効化、無効化、および禁止」 を参照してください。

- Pacemaker がリソースに対するアクションを実行するのを防ぐ必要がある場合(たとえば、リソースに対するメンテナンスの実行中に復元アクションを無効にする必要がある場合や、

/etc/sysconfig/pacemaker設定をリロードする必要がある場合)、「管理リソース」 の説明にあるように pcs resource unmanage コマンドを使用します。Pacemaker Remote 接続リソースは、非管理モードにしないでください。 - クラスターを、サービスが開始または停止されない状態にする必要がある場合は、

maintenance-modeクラスタープロパティーを設定できます。クラスターをメンテナンスモードにすると、すべてのリソースが自動的に非管理モードになります。クラスターのプロパティーの詳細は 表12.1「クラスターのプロパティー」 を参照してください。 - Pacemaker リモートノードでメンテナンスを実行する必要がある場合、「システムアップグレードおよび pacemaker_remote」 で説明しているように、リモートノードリソースを無効にすることで、ノードをクラスターから削除できます。

第5章 フェンス機能: STONITH の設定

STONITH は Shoot The Other Node In The Head の頭字語で、不安定なノードや同時アクセスによるデータの破損を防ぐことができます。

ノードが無反応だからと言ってデータにアクセスしていないとは限りません。STONITH を使ってノードを排他処理することが唯一 100% 確実にデータの安全を確保する方法になります。排他処理することによりそのノードを確実にオフラインにしてから、別のノードに対してデータへのアクセスを許可することができます。

STONITH はクラスター化したサービスを停止できない場合にも役に立ちます。この場合は、クラスターが STONITH を使用してノード全体を強制的にオフラインにし、その後サービスを別の場所で開始すると安全です。

フェンシングの概要と、Red Hat High Availability クラスターにおけるフェンシングの重要性はRHEL 高可用性クラスターでフェンシングが重要なのはなぜですか ?を参照してください。

5.1. STONITH (フェンス) エージェント

以下のコマンドは、利用可能な STONITH エージェントをリスト表示します。フィルターを指定するとフィルターに一致する STONITH エージェントのみを表示します。

pcs stonith list [filter]

5.2. フェンスデバイスの一般的なプロパティー

クラスターノードは、フェンスリソースが開始しているかどうかに関わらず、フェンスデバイスでその他のクラスターノードをフェンスできます。以下の例外を除き、リソースが開始しているかどうかは、デバイスの定期的なモニターのみを制御するものとなり、使用可能かどうかは制御しません。

- フェンスデバイスを無効にするには、pcs stonith disable stonith_id コマンドを実行します。これにより、ノードがそのデバイスを使用できないようにすることができます。

- 特定のノードがフェンスデバイスを使用できないようにするには、pcs constraint location ... avoids コマンドを使用して、フェンシングリソースの場所制約を設定できます。

stonith-enabled=falseを設定すると、フェンシングがすべて無効になります。ただし、実稼働環境でフェンシングを無効にすることは適していないため、フェンシングが無効になっている場合は、Red Hat ではクラスターがサポートされないことに注意してください。

表5.1「フェンスデバイスの一般的なプロパティー」 は、フェンスデバイスに設定できる一般的なプロパティーを説明します。特定のフェンスデバイスに設定できるフェンスプロパティーについては 「デバイス固有のフェンスオプションの表示」 を参照してください。

注記

より高度なフェンス設定プロパティーについては 「その他のフェンス設定オプション」 を参照してください。

| フィールド | タイプ | デフォルト | 説明 |

|---|---|---|---|

pcmk_host_map | 文字列 | ホスト名を、ホスト名に対応していないデバイスのポート番号へマッピングします。たとえば、node1:1 ;node2:2, 3 の場合は、node1 にはポート 1 を使用し、node2 にはポート 2 と 3 を使用するようにクラスターに指示します。 | |

pcmk_host_list | 文字列 | このデバイスによって制御されるマシンのリスト( pcmk_host_check=static-list以外オプション)。 | |

pcmk_host_check | 文字列 | dynamic-list | デバイスで制御するマシンを指定します。許可される値: dynamic-list (デバイスのクエリー)、static-list ( pcmk_host_list 属性の確認)、none (すべてのデバイスがすべてのマシンをフェンスできると仮定) |

5.3. デバイス固有のフェンスオプションの表示

指定した STONITH エージェントのオプションを表示するには、次のコマンドを使用します。

pcs stonith describe stonith_agent

次のコマンドでは Telnet または SSH 経由の APC 用フェンスエージェントのオプションを表示します。

# pcs stonith describe fence_apc

Stonith options for: fence_apc

ipaddr (required): IP Address or Hostname

login (required): Login Name

passwd: Login password or passphrase

passwd_script: Script to retrieve password

cmd_prompt: Force command prompt

secure: SSH connection

port (required): Physical plug number or name of virtual machine

identity_file: Identity file for ssh

switch: Physical switch number on device

inet4_only: Forces agent to use IPv4 addresses only

inet6_only: Forces agent to use IPv6 addresses only

ipport: TCP port to use for connection with device

action (required): Fencing Action

verbose: Verbose mode

debug: Write debug information to given file

version: Display version information and exit

help: Display help and exit

separator: Separator for CSV created by operation list

power_timeout: Test X seconds for status change after ON/OFF

shell_timeout: Wait X seconds for cmd prompt after issuing command

login_timeout: Wait X seconds for cmd prompt after login

power_wait: Wait X seconds after issuing ON/OFF

delay: Wait X seconds before fencing is started

retry_on: Count of attempts to retry power on

警告

method オプションを提供するフェンスエージェントでは cycle の値がサポートされないため、データの破損が発生する可能性があるため、この値は指定できません。

5.4. フェンスデバイスの作成

次のコマンドで stonith デバイスを作成します。

pcs stonith create stonith_id stonith_device_type [stonith_device_options]

# pcs stonith create MyStonith fence_virt pcmk_host_list=f1 op monitor interval=30s

1 つのノードのみをフェンスできるフェンスデバイスや、複数のノードをフェンスできるデバイスもあります。フェンスデバイスの作成時に指定するパラメーターは、フェンスデバイスが対応しているか、必要としているかにより異なります。

- フェンスデバイスの中には、フェンスできるノードを自動的に判断できるものがあります。

- フェンスデバイスの作成時に

pcmk_host_listパラメーターを使用すると、フェンスデバイスで制御されるすべてのマシンを指定できます。 - フェンスデバイスによっては、フェンスデバイスが理解する仕様へのホスト名のマッピングが必要となるものがあります。フェンスデバイスの作成時に、

pcmk_host_mapパラメーターを使用してホスト名をマッピングできます。

フェンスデバイスを設定したら、デバイスをテストして正しく機能していることを確認してください。フェンスデバイスのテストの詳細は 「フェンスデバイスのテスト」 を参照してください。

5.5. フェンスデバイスの表示

以下のコマンドは現在設定されているフェンスデバイスをすべて表示します。stonith_id が指定されていると、指定された stonith デバイスのオプションのみが表示されます。

--full オプションを指定すると、設定した stonith オプションがすべて表示されます。

pcs stonith show [stonith_id] [--full]

5.6. フェンスデバイスの修正と削除

現在設定されているフェンスデバイスのオプションを修正したり、新たにオプションを追加する場合は次のコマンドを使用します。

pcs stonith update stonith_id [stonith_device_options]

現在の設定からフェンスデバイスを削除する場合は次のコマンドを使用します。

pcs stonith delete stonith_id

5.7. フェンスデバイスが接続されているノードの管理

次のコマンドで、ノードを手動でフェンスできます。

--off を指定すると、stonith への off API 呼び出しが使用され、ノードを再起動する代わりにオフになります。

pcs stonith fence node [--off]

ノードがアクティブでない場合でも、そのノードを stonith デバイスがフェンスできない状況では、そのノードのリソースをクラスターが復旧できない可能性があります。この場合は、ノードの電源が切れたことを手動で確認した後、次のコマンドを入力して、ノードの電源が切れたことをクラスターに確認し、そのリソースを回復のために解放できます。

警告

指定したノードが実際にオフになっていない状態で、クラスターソフトウェア、または通常クラスターが制御するサービスを実行すると、データ破損またはクラスター障害が発生します。

pcs stonith confirm node

5.8. その他のフェンス設定オプション

フェンスデバイスに設定できるその他のプロパティーは 表5.2「フェンスデバイスの高度なプロパティー」 にまとめられています。これらのオプションは高度な設定を行う場合にのみ使用されます。

| フィールド | タイプ | デフォルト | 説明 |

|---|---|---|---|

pcmk_host_argument | 文字列 | port | port の代替パラメーターです。デバイスによっては、標準の port パラメーターに対応していない場合や、そのデバイス固有のパラメーターも提供している場合があります。このパラメーターを使用して、フェンスするマシンを示すデバイス固有の代替パラメーターを指定します。クラスターが追加パラメーターを提供しないようにする場合は、none 値を使用します。 |

pcmk_reboot_action | 文字列 | reboot | 再起動 の代わりに実行する別のコマンド。標準的なコマンドに対応していないデバイスや、別のコマンドを提供しているデバイスがあります。このパラメーターを使用して、再起動を実行するデバイス固有の代替コマンドを指定します。 |

pcmk_reboot_timeout | 時間 | 60s | stonith-timeout の代わりに、再起動アクションに使用するタイムアウトを指定します。再起動が完了するまでに通常より長い時間を要するデバイスもあれば、通常より短い時間で完了するデバイスもあります。このパラメーターを使用して、再起動にデバイス固有のタイムアウトを指定します。 |

pcmk_reboot_retries | 整数 | 2 | タイムアウト期間内に、reboot コマンドを再試行する回数の上限です。複数の接続に対応していないデバイスもあります。デバイスが別のタスクでビジー状態になると操作が失敗する場合があるため、タイムアウトに達していなければ、Pacemaker が操作を自動的に再試行します。Pacemaker による再起動の動作の再試行回数を変更する場合に使用します。 |

pcmk_off_action | 文字列 | off | オフ の代わりに実行する代替コマンド。標準的なコマンドに対応していないデバイスや、別のコマンドを提供しているデバイスがあります。このような場合は、このパラメーターを使用して、オフ操作を実行するデバイス固有のコマンドを指定します。 |

pcmk_off_timeout | 時間 | 60s | stonith-timeout の代わりに、オフアクションに使用する別のタイムアウトを指定します。デバイスによって、この操作が完了するのにかかる時間が、通常と大きく異なる場合があります。このパラメーターを使用して、オフ操作にデバイス固有のタイムアウトを指定します。 |

pcmk_off_retries | 整数 | 2 | タイムアウト期間内に、off コマンドを再試行する回数の上限です。複数の接続に対応していないデバイスもあります。デバイスが別のタスクでビジー状態になると操作が失敗する場合があるため、タイムアウトに達していなければ、Pacemaker が操作を自動的に再試行します。Pacemaker によるオフ動作の再試行回数を変更する場合に使用します。 |

pcmk_list_action | 文字列 | list | list の代わりに実行する別のコマンド。標準的なコマンドに対応していないデバイスや、別のコマンドを提供しているデバイスがあります。このような場合は、このパラメーターを使用して、list 操作を実行するデバイス固有のコマンドを指定します。 |

pcmk_list_timeout | 時間 | 60s | stonith-timeout の代わりに、list 操作に使用する別のタイムアウトを指定します。デバイスによって、この操作が完了するのにかかる時間が、通常と大きく異なる場合があります。このパラメーターを使用して、list 操作にデバイス固有のタイムアウトを指定します。 |

pcmk_list_retries | 整数 | 2 | タイムアウト期間内に、list コマンドを再試行する回数の上限です。複数の接続に対応していないデバイスもあります。デバイスが別のタスクでビジー状態になると操作が失敗する場合があるため、タイムアウトに達していなければ、Pacemaker が操作を自動的に再試行します。Pacemaker による list 動作の再試行回数を変更する場合に使用します。 |

pcmk_monitor_action | 文字列 | monitor | monitor の代わりに実行する代替コマンド。標準的なコマンドに対応していないデバイスや、別のコマンドを提供しているデバイスがあります。このような場合は、このパラメーターを使用して、監視操作を実行するデバイス固有のコマンドを指定します。 |

pcmk_monitor_timeout | 時間 | 60s | stonith-timeout の代わりに、監視アクションに使用する別のタイムアウトを指定します。デバイスによって、この操作が完了するのにかかる時間が、通常と大きく異なる場合があります。このパラメーターを使用して、監視操作にデバイス固有のタイムアウトを指定します。 |

pcmk_monitor_retries | 整数 | 2 | タイムアウト期間内に、monitor コマンドを再試行する回数の上限です。複数の接続に対応していないデバイスもあります。デバイスが別のタスクでビジー状態になると操作が失敗する場合があるため、タイムアウトに達していなければ、Pacemaker が操作を自動的に再試行します。Pacemaker による監視操作の再試行回数を変更する場合に使用します。 |

pcmk_status_action | 文字列 | status | status の代わりに実行する代替コマンド。標準的なコマンドに対応していないデバイスや、別のコマンドを提供しているデバイスがあります。このような場合は、このパラメーターを使用して、status 操作を実行するデバイス固有のコマンドを指定します。 |

pcmk_status_timeout | 時間 | 60s | stonith-timeout の代わりに、ステータス動作に使用する別のタイムアウトを指定します。デバイスによって、この操作が完了するのにかかる時間が、通常と大きく異なる場合があります。このパラメーターを使用して、status 操作にデバイス固有のタイムアウトを指定します。 |

pcmk_status_retries | 整数 | 2 | タイムアウト期間内に、status コマンドを再試行する回数の上限です。複数の接続に対応していないデバイスもあります。デバイスが別のタスクでビジー状態になると操作が失敗する場合があるため、タイムアウトに達していなければ、Pacemaker が操作を自動的に再試行します。Pacemaker による status 動作の再試行回数を変更する場合に使用します。 |

pcmk_delay_base | 時間 | 0s |

stonith 操作のベース遅延を有効にし、ベース遅延の値を指定します。ノードの数が偶数になるクラスターでは、遅延を設定すると、均等の分割時に同時にノードが互いにフェンシングするのを回避できます。ランダムな遅延は、すべてのノードに同じフェンスデバイスが使用されている場合に役に立つことがあります。また、静的遅延を変更すると、各ノードで異なるデバイスが使用される場合に各フェンシングデバイスで役に立つことがあります。全体の遅延は、合計が最大遅延を下回るように、ランダムな遅延値に静的遅延を加算します。

pcmk_delay_base を設定し、pcmk_delay_max を設定しない場合は、遅延にランダムなコンポーネントがなく、pcmk_delay_base の値になります。

個々のフェンスエージェントには delay パラメーターが実装されています。これは、

pcmk_delay_* プロパティーで設定された遅延とは依存しません。この遅延の両方が設定されている場合は、その両方が一緒に追加されるため、通常は併用されません。

|

pcmk_delay_max | 時間 | 0s |

stonith 動作のランダムな遅延を有効にし、ランダムな遅延の最大値を指定します。ノードの数が偶数になるクラスターでは、遅延を設定すると、均等の分割時に同時にノードが互いにフェンシングするのを回避できます。ランダムな遅延は、すべてのノードに同じフェンスデバイスが使用されている場合に役に立つことがあります。また、静的遅延を変更すると、各ノードで異なるデバイスが使用される場合に各フェンシングデバイスで役に立つことがあります。全体の遅延は、合計が最大遅延を下回るように、このランダムな遅延値に静的遅延を加算します。

pcmk_delay_max を設定し、pcmk_delay_base を設定しない場合は、静的コンポーネントが遅延に含まれません。

個々のフェンスエージェントには delay パラメーターが実装されています。これは、

pcmk_delay_* プロパティーで設定された遅延とは依存しません。この遅延の両方が設定されている場合は、その両方が一緒に追加されるため、通常は併用されません。

|

pcmk_action_limit | 整数 | 1 | このデバイスで並行して実行できる操作の上限です。最初に、クラスタープロパティーの concurrent-fencing=true を設定する必要があります。値を -1 にすると無制限になります。 |

pcmk_on_action | 文字列 | on | 高度な使用のみ: on の代わりに実行する代替コマンド。標準的なコマンドに対応していないデバイスや、別のコマンドを提供しているデバイスがあります。このパラメーターを使用して、on アクションを実装するデバイス固有のコマンドを指定します。 |

pcmk_on_timeout | 時間 | 60s | 高度な使用のみ: stonith-timeout の代わりに、on 操作に使用する別のタイムアウトを指定します。デバイスによって、この操作が完了するのにかかる時間が、通常と大きく異なる場合があります。このパラメーターを使用して、on 操作にデバイス固有のタイムアウトを指定します。 |

pcmk_on_retries | 整数 | 2 | 高度な使用のみ:タイムアウト期間内に、on コマンドを再試行する最大回数。複数の接続に対応していないデバイスもあります。デバイスが別のタスクでビジー状態になると操作が失敗する場合があるため、タイムアウトに達していなければ、Pacemaker が操作を自動的に再試行します。Pacemaker による on 動作の再試行回数を変更する場合に使用します。 |

表12.1「クラスターのプロパティー」 の説明にあるように、

fence-reaction クラスタープロパティーを設定すると、クラスターノードが独自のフェンシングの通知を受信した場合にどのように反応するかを決定できます。クラスターノードは、フェンシングの設定が間違っている場合に独自のフェンシングの通知を受信するか、ファブリックフェンシングがクラスター通信を遮断しない状態である可能性があります。このプロパティーのデフォルト値は stop (Pacemaker をすぐに停止して停止し続ける)ですが、この値に最も安全な選択肢は panic で、ローカルノードをすぐに再起動しようとします。停止動作を希望する場合は、おそらくファブリックフェンシングと併用する場合は、明示的に指定することが推奨されます。

5.9. フェンスレベルの設定

Pacemaker は、フェンストポロジーと呼ばれる機能を用いて、複数デバイスでのノードのフェンシングに対応します。トポロジーを実装するには、通常の方法で各デバイスを作成し、設定のフェンストポロジーセクションでフェンスレベルを 1 つ以上定義します。

- レベルは、1 から昇順で試行されていきます。

- デバイスに障害が発生すると、現在のレベルの処理が終了します。同レベルのデバイスには試行されず、次のレベルが試行されます。

- すべてのデバイスのフェンシングが正常に完了すると、そのレベルが継承され、他のレベルは試行されなくなります。

- いずれかのレベルで成功するか、すべてのレベルが試行され失敗すると、操作は終了します。

ノードにフェンスレベルを追加する場合は、次のコマンドを使用します。デバイスは、stonith ID をコンマで区切って指定します。stonith ID が、指定したレベルで試行されます。

pcs stonith level add level node devices

次のコマンドを使用すると現在設定されている全フェンスレベルが表示されます。

pcs stonith level

以下の例では、ノード

rh7- 2 にフェンスデバイスが my_ilo と呼ばれる ilo フェンスデバイスと、my_apc という apc フェンスデバイスが設定されています。このコマンドはフェンスレベルを設定し、デバイス my_ilo に障害が発生し、ノードがフェンスできない場合に、Pacemaker がデバイス my_apc の使用を試みるようにします。この例では、レベル設定後の pcs stonith level コマンドの出力も示しています。

#pcs stonith level add 1 rh7-2 my_ilo#pcs stonith level add 2 rh7-2 my_apc#pcs stonith levelNode: rh7-2 Level 1 - my_ilo Level 2 - my_apc

次のコマンドは、指定したノードおよびデバイスのフェンスレベルを削除します。ノードやデバイスを指定しないと、指定したフェンスレベルがすべてのノードから削除されます。

pcs stonith level remove level [node_id] [stonith_id] ... [stonith_id]

以下のコマンドを使用すると、指定したノードや stonith id のフェンスレベルが削除されます。ノードや stonith id を指定しないと、すべてのフェンスレベルが削除されます。

pcs stonith level clear [node|stonith_id(s)]

複数の stonith ID を指定する場合はコンマで区切って指定します。空白は入力しないでください。以下に例を示します。

# pcs stonith level clear dev_a,dev_b

次のコマンドは、フェンスレベルで指定されたフェンスデバイスとノードがすべて存在することを確認します。

pcs stonith level verify

Red Hat Enterprise Linux 7.4 では、フェンストポロジーのノードは、ノード名に適用する正規表現と、ノードの属性 (およびその値) で指定できます。たとえば、以下のコマンドでは、ノード

node1、node2、およびnode3 を、フェンスデバイス apc1 およびapc2 を使用するように、ノードnode4、node5、およびnode6 を設定して、フェンスデバイス apc3 およびapc4 を使用します。

pcs stonith level add 1 "regexp%node[1-3]" apc1,apc2 pcs stonith level add 1 "regexp%node[4-6]" apc3,apc4

次のコマンドでは、ノード属性のマッチングを使用して、同じように設定します。

pcs node attribute node1 rack=1 pcs node attribute node2 rack=1 pcs node attribute node3 rack=1 pcs node attribute node4 rack=2 pcs node attribute node5 rack=2 pcs node attribute node6 rack=2 pcs stonith level add 1 attrib%rack=1 apc1,apc2 pcs stonith level add 1 attrib%rack=2 apc3,apc4

5.10. 冗長電源のフェンシング設定

冗長電源にフェンシングを設定する場合は、ホストを再起動するときに、クラスターが、最初に両方の電源をオフにしてから、いずれかの電源をオンにするようにする必要があります。

ノードの電源が完全にオフにならないと、ノードがリソースを解放しない場合があります。このとき、解放できなかったリソースに複数のノードが同時にアクセスして、リソースが破損する可能性があります。

Red Hat Enterprise Linux 7.2 より古いバージョンでは、オンまたはオフのアクションを使用するデバイスで異なるバージョンを明示的に設定する必要がありました。Red Hat Enterprise Linux 7.2 では、以下の例のように各デバイスを 1 度定義して、ノードのフェンシングに両方が必要であることを指定するだけで済むようになりました。

#pcs stonith create apc1 fence_apc_snmp ipaddr=apc1.example.com login=user passwd='7a4D#1j!pz864' pcmk_host_map="node1.example.com:1;node2.example.com:2"#pcs stonith create apc2 fence_apc_snmp ipaddr=apc2.example.com login=user passwd='7a4D#1j!pz864' pcmk_host_map="node1.example.com:1;node2.example.com:2"#pcs stonith level add 1 node1.example.com apc1,apc2#pcs stonith level add 1 node2.example.com apc1,apc2

5.11. 統合フェンスデバイスで使用する ACPI の設定

クラスターが統合フェンスデバイスを使用する場合は、即時かつ完全なフェンシングを実行できるように、ACPI (Advanced Configuration and Power Interface) を設定する必要があります。

クラスターノードが統合フェンスデバイスでフェンシングされるように設定されている場合は、そのノードの ACPI Soft-Off を無効にします。ACPI Soft-Off を無効にすると、統合フェンスデバイスはクリーンシャットダウンを試行するのではなく、ノードを即時かつ完全にオフにできます(例: shutdown -h now)。それ以外の場合は、ACPI Soft-Off が有効になっていると、統合フェンスデバイスがノードをオフにするのに 4 秒以上かかることがあります (以下の注記部分を参照してください)。さらに、ACPI Soft-Off が有効になっていて、ノードがシャットダウン時にパニック状態になるか、フリーズすると、統合フェンスデバイスがノードをオフにできない場合があります。このような状況では、フェンシングが遅延するか、失敗します。したがって、ノードが統合フェンスデバイスでフェンシングされ、ACPI Soft-Off が有効になっている場合は、クラスターが徐々に復元します。または管理者の介入による復旧が必要になります。

注記

ノードのフェンシングにかかる時間は、使用している統合フェンスデバイスによって異なります。統合フェンスデバイスの中には、電源ボタンを押し続けるのと同じ動作を実行するものもあります。この場合は、ノードがオフになるのに 4 秒から 5 秒かかります。また、電源ボタンを押してすぐ離すのと同等の動作を行い、ノードの電源をオフにする行為をオペレーティングシステムに依存する統合フェンスデバイスもあります。この場合は、ノードがオフになるのにかかる時間は 4~ 5 秒よりも長くなります。

- ACPI Soft-Off を無効にする場合は、BIOS 設定を instant-off、またはこれに類似する設定に変更することが推奨されます。これにより、「BIOS で ACPI Soft-Off を無効化」 で説明しているように、ノードは遅延なくオフになります。

システムによっては、BIOS で ACPI Soft-Off を無効にできません。お使いのクラスターでは、BIOS で ACPI Soft-Off を無効にできない場合に、以下のいずれかの方法で ACPI Soft-Off を無効にできます。

- 「logind.conf ファイルで ACPI Soft-Off の無効化」 の説明に従って、

HandlePowerKey=ignoreを/etc/systemd/logind.confファイルに設定し、ノードがフェンシングされるとすぐにオフになることを確認します。これが、ACPI Soft-Off を無効にする 1 つ目の代替方法です。 acpi=offで説明されているように、カーネル起動コマンドラインに 「GRUB 2 ファイルでの ACPI の完全な無効化」 を追加します。これは、ACPI Soft-Off を無効にする 2 つ目の代替方法です。この方法の使用が推奨される場合、または 1 つ目の代替方法が利用できない場合に使用してください。重要この方法は、ACPI を完全に無効にします。コンピューターの中には、ACPI が完全が無効になってるとシステムが正しく起動しないものもあります。お使いのクラスターに適した方法が他にない場合に 限り、この方法を使用してください。

5.11.1. BIOS で ACPI Soft-Off を無効化

以下の手順で、各クラスターノードの BIOS を設定して、ACPI Soft-Off を無効にできます。

注記

BIOS で ACPI Soft-Off を無効にする手順は、サーバーシステムにより異なる場合があります。この手順は、お使いのハードウェアのドキュメントで確認する必要があります。

- ノードを再起動して、BIOS CMOS セットアップユーティリティー プログラムを起動します。

- 管理メニュー)に移動します。

- メニューで、 (またはそれと同等の機能)を に設定します(または、遅延なく電源ボタンでノードをオフにする同等の設定)。例5.1「BIOS CMOS セットアップユーティリティー: を に設定します。」 が に設定された メニューを表示します。注記に相当するものは、コンピューターごとに異なる場合があります。ただし、この手順の目的は、電源ボタンを使用して遅延なしにコンピューターをオフにするように BIOS を設定することです。

- BIOS CMOS セットアップユーティリティー プログラムを終了し、BIOS 設定を保存します。

- ノードがフェンシングされるとすぐにオフになることを確認します。フェンスデバイスのテストの詳細は 「フェンスデバイスのテスト」 を参照してください。

例5.1 BIOS CMOS セットアップユーティリティー: を に設定します。

+---------------------------------------------|-------------------+ | ACPI Function [Enabled] | Item Help | | ACPI Suspend Type [S1(POS)] |-------------------| | x Run VGABIOS if S3 Resume Auto | Menu Level * | | Suspend Mode [Disabled] | | | HDD Power Down [Disabled] | | | Soft-Off by PWR-BTTN [Instant-Off | | | CPU THRM-Throttling [50.0%] | | | Wake-Up by PCI card [Enabled] | | | Power On by Ring [Enabled] | | | Wake Up On LAN [Enabled] | | | x USB KB Wake-Up From S3 Disabled | | | Resume by Alarm [Disabled] | | | x Date(of Month) Alarm 0 | | | x Time(hh:mm:ss) Alarm 0 : 0 : | | | POWER ON Function [BUTTON ONLY | | | x KB Power ON Password Enter | | | x Hot Key Power ON Ctrl-F1 | | | | | | | | +---------------------------------------------|-------------------+

以下の例は、 を に設定し、 に設定していることを示しています。

5.11.2. logind.conf ファイルで ACPI Soft-Off の無効化

/etc/systemd/logind.conf ファイルで電源キーの処理を無効にするには、以下の手順を行います。

/etc/systemd/logind.confファイルで以下の設定を定義します。HandlePowerKey=ignore

systemd設定をリロードします。#

systemctl daemon-reload- ノードがフェンシングされるとすぐにオフになることを確認します。フェンスデバイスのテストの詳細は 「フェンスデバイスのテスト」 を参照してください。

5.11.3. GRUB 2 ファイルでの ACPI の完全な無効化

カーネルの GRUB メニューエントリーに

acpi=off を追加すると、ACPI Soft-Off を無効にできます。

重要

この方法は、ACPI を完全に無効にします。コンピューターの中には、ACPI が完全が無効になってるとシステムが正しく起動しないものもあります。お使いのクラスターに適した方法が他にない場合に 限り、この方法を使用してください。

以下の手順で、GRUB 2 ファイルで ACPI を無効にします。

- 以下のように

--argsオプションを grubby ツールの--update-kernelオプションと組み合わせて使用し、各クラスターノードのgrub.cfgファイルを変更します。#

grubby --args=acpi=off --update-kernel=ALLGRUB 2 の概要は、 システム管理者のガイド のGRUB 2 での作業を参照してください。 - ノードを再起動します。

- ノードがフェンシングされるとすぐにオフになることを確認します。フェンスデバイスのテストの詳細は 「フェンスデバイスのテスト」 を参照してください。

5.12. フェンスデバイスのテスト

フェンシングは、Red Hat Cluster インフラストラクチャーの基本的な部分を設定しているため、フェンシングが適切に機能していることの確認またはテストを行うことは重要です。

以下の手順で、フェンスデバイスをテストします。

- デバイスへの接続に使用する ssh、telnet、HTTP などのリモートプロトコルを使用して、手動でログインしてフェンスデバイスをテストしたり、出力される内容を確認します。たとえば、IPMI 対応デバイスのフェンシングを設定する場合は、ipmitool を使用してリモートでログインしてみてください。手動でログインする際に使用するオプションに注意してください。これらのオプションは、フェンスエージェントを使用する際に必要になる場合があります。フェンスデバイスにログインできない場合は、そのデバイスが ping 可能であること、ファイアウォール設定フェンスデバイスへのアクセスを妨げていないこと、フェンスエージェントでリモートアクセスが有効になっていること、認証情報が正しいことなどを確認します。

- フェンスエージェントスクリプトを使用して、フェンスエージェントを手動で実行します。フェンスエージェントを実行するのに、クラスターサービスが実行している必要はないため、デバイスをクラスターに設定する前にこのステップを完了できます。これにより、先に進む前に、フェンスデバイスが適切に応答することを確認できます。注記本セクションの例では、iLO デバイスの fence_ilo フェンスエージェントスクリプトを使用します。実際に使用するフェンスエージェントと、そのエージェントを呼び出すコマンドは、お使いのサーバーハードウェアによって異なります。指定するオプションを確認するには、フェンスエージェントの man ページを参照してください。通常は、フェンスデバイスのログイン、パスワードなどの情報と、その他のフェンスデバイスに関する情報を把握しておく必要があります。以下の例は、

-o statusパラメーターを指定して fence_ilo フェンスエージェントスクリプトを実行する場合に使用する形式になります。ノードの再起動を試行する前にデバイスをテストして、動作させることができます。このコマンドを実行する際に、iLO デバイスの電源をオン/オフにするパーミッションを持つ iLO ユーザーの名前およびパスワードを指定します。#

fence_ilo -a ipaddress -l username -p password -o status以下の例は、-o rebootパラメーターを指定して fence_ilo フェンスエージェントスクリプトを実行するために使用する形式になります。このコマンドをノードで実行すると、フェンスエージェントを設定した別のノードが再起動します。#

fence_ilo -a ipaddress -l username -p password -o rebootフェンスエージェントがステータス、オフ、オン、または再起動の動作を適切に実行しない場合は、ハードウェア、フェンスデバイスの設定、およびコマンドの構文を確認する必要があります。さらに、デバッグ出力を有効にした状態で、フェンスエージェントスクリプトを実行できます。デバッグ出力は、一部のフェンスエージェントで、フェンスデバイスにログインする際に、フェンスエージェントスクリプトに問題が発生しているイベントシーケンスの場所を確認するのに役に立ちます。#

fence_ilo -a ipaddress -l username -p password -o status -D /tmp/$(hostname)-fence_agent.debug発生した障害を診断する際に、フェンスデバイスに手動でログインする際に指定したオプションが、フェンスエージェントスクリプトでフェンスエージェントに渡した内容と同一であることを確認する必要があります。フェンスエージェントが暗号化された接続をサポートする場合は、証明書の検証の失敗によりエラーが表示され、ホストを信頼するか、フェンスエージェントのssl-insecureパラメーターを使用する必要があります。同様に、ターゲットデバイスで SSL/TLS を無効にした場合は、フェンスエージェントに SSL パラメーターを設定する際に、これを考慮しないといけない場合があります。注記テスト中のフェンスエージェントが fence_drac、fence_ilo、またはその他のシステム管理デバイスのフェンスエージェントで、引き続き失敗する場合は、フォールバックして fence_ipmilan を試行します。ほとんどのシステム管理カードは IPMI リモートログインに対応しており、フェンシングエージェントとしては fence_ipmilan だけに対応しています。 - フェンスデバイスを、手動で機能したオプションと同じオプションでクラスターに設定し、クラスターが起動したら、以下の例のように、任意のノードから pcs stonith fence コマンドを使用してフェンシングをテストします(または異なるノードから複数回実行します)。pcs stonith fence コマンドは、CIB からクラスター設定を読み取り、フェンスアクションを実行するように設定されたときにフェンスエージェントを呼び出します。これにより、クラスター設定が正確であることが確認できます。

#

pcs stonith fence node_namepcs stonith fence コマンドが正しく機能した場合、フェンスイベントの発生時にクラスターのフェンシング設定が機能します。このコマンドが失敗すると、クラスター管理が取得した設定でフェンスデバイスを起動することができません。以下の問題を確認し、必要に応じてクラスター設定を更新します。- フェンス設定を確認します。たとえば、ホストマップを使用したことがある場合は、指定したホスト名を使用して、システムがノードを見つけられるようにする必要があります。

- デバイスのパスワードおよびユーザー名に、bash シェルが誤って解釈する可能性がある特殊文字が含まれるかどうかを確認します。パスワードとユーザー名を引用符で囲んで入力すると、この問題に対処できます。

- pcs stonith コマンドで IP アドレスまたはホスト名を使用してデバイスに接続できるかどうかを確認します。たとえば、stonith コマンドでホスト名を指定し、IP アドレスを使用して行ったテストは有効ではありません。

- お使いのフェンスデバイスが使用するプロトコルにアクセスできる場合は、そのプロトコルを使用してデバイスへの接続を試行します。たとえば、多くのエージェントが ssh または telnet を使用します。デバイスへの接続は、デバイスの設定時に指定した認証情報を使用して試行する必要があります。これにより、有効なプロンプトを取得し、そのデバイスにログインできるかどうかを確認できます。

すべてのパラメーターが適切であることが確認できたものの、フェンスデバイスには接続できない時に、フェンスデバイスでログ機能が使用できる場合は、ログを確認できます。これにより、ユーザーが接続したかどうかと、ユーザーが実行したコマンドが表示されます。また、/var/log/messagesファイルで stonith やエラーを検索することもできます。これにより、転送しているものの、エージェントによっては追加情報が提供される場合があります。 - フェンスデバイステストに成功し、クラスターが稼働したら、実際の障害をテストします。このテストでは、クラスターで、トークンの損失を生じさせる動作を実行します。

- ネットワークを停止します。ネットワークの利用方法は、設定により異なります。ただし、多くの場合は、ネットワークケーブルまたは電源ケーブルをホストから物理的に抜くことができます。注記ネットワークや電源ケーブルを物理的に切断せずに、ローカルホストのネットワークインターフェイスを無効にすることは、フェンシングのテストとしては推奨されません。実際に発生する障害を正確にシミュレートしていないためです。

- ローカルのファイアウォールを使用して、corosync の受信トラフィックおよび送信トラフィックをブロックします。以下の例では corosync をブロックします。ここでは、デフォルトの corosync ポートが使用され、

firewalldがローカルファイアウォールとして使用し、corosync が使用するネットワークインターフェイスがデフォルトのファイアウォールゾーンにあることを前提とします。#

firewall-cmd --direct --add-rule ipv4 filter OUTPUT 2 -p udp --dport=5405 -j DROP#firewall-cmd --add-rich-rule='rule family="ipv4" port port="5405" protocol="udp" drop' - クラッシュをシミュレートし、マシンを

sysrq-triggerでパニックにします。ただし、カーネルパニックを発生させると、データが損失する可能性があることに注意してください。クラッシュする前に、クラスターリソースを無効にすることが推奨されます。#

echo c > /proc/sysrq-trigger

第6章 クラスターリソースの設定

本章ではクラスター内にリソースを設定する方法について説明していきます。

6.1. リソースの作成

次のコマンドを使用してクラスターリソースを作成します。

pcs resource create resource_id [standard:[provider:]]type [resource_options] [op operation_action operation_options [operation_action operation options]...] [meta meta_options...] [clone [clone_options] | master [master_options] | --group group_name [--before resource_id | --after resource_id] | [bundle bundle_id] [--disabled] [--wait[=n]]

--group オプションを指定すると、名前付きのリソースグループにリソースが追加されます。グループが存在しない場合は作成され、そのグループにリソースが追加されます。リソースグループの詳細は 「リソースグループ」 を参照してください。

--before および --after オプションは、リソースグループに含まれるリソースを基準にして、追加するリソースの位置を指定します。

--disabled オプションは、リソースが自動的に起動しないことを示しています。

次のコマンドは、標準

ocf、プロバイダー heartbeat、およびタイプ IPaddr2 という名前の VirtualIP という名前のリソースを作成します。このリソースのフローティングアドレスは 192.168.0.120 で、システムはリソースが 30 秒毎に実行されるかどうかをチェックします。

# pcs resource create VirtualIP ocf:heartbeat:IPaddr2 ip=192.168.0.120 cidr_netmask=24 op monitor interval=30s

standard と provider のフィールドを省略して次のようにすることもできます。デフォルトは

ocf の標準および ハートビート のプロバイダーに設定されます。

# pcs resource create VirtualIP IPaddr2 ip=192.168.0.120 cidr_netmask=24 op monitor interval=30s

設定したリソースを削除する場合は、次のコマンドを実行します。

pcs resource delete resource_id

たとえば、次のコマンドは、リソース ID が

VirtualIPの既存のリソースを削除します。

# pcs resource delete VirtualIP- pcs resource create コマンドのフィールド resource_id、standard、provider、および type フィールドの詳細は、「リソースのプロパティー」 を参照してください。

- リソースごとにパラメーターを指定する方法は 「リソース固有のパラメーター」 を参照してください。

- リソースの動作をクラスターが決定する場合に使用するリソースのメタオプションを定義する方法は 「リソースのメタオプション」 を参照してください。

- リソースで行う動作を定義する方法は 「リソースの動作」 を参照してください。

cloneオプションを指定すると、クローンリソースが作成されます。masterオプションを指定すると、クローンリソースが作成されます。リソースのクローンや、複数モードのリソースに関する詳細は 9章高度な設定 を参照してください。

6.2. リソースのプロパティー

リソースに定義するプロパティーを使ってリソースに使用するスクリプト、スクリプトの格納先、準拠すべき標準をクラスターに指示します。表6.1「リソースのプロパティー」 では、このプロパティーを説明します。

| フィールド | 説明 |

|---|---|

|

resource_id

| |

|

standard

| |

|

type

| |

|

provider

|

表6.2「リソースプロパティーを表示させるコマンド」 は、利用可能なリソースプロパティーを表示するコマンドの概要を示しています。

| pcs 表示コマンド | 出力 |

|---|---|

| pcs resource list | 利用できる全リソースのリストを表示 |

| pcs resource standards | 利用できるリソースエージェントの標準を表示 |

| pcs resource providers | 利用できるリソースエージェントのプロバイダーを表示 |

| pcs resource list string | 利用できるリソースを指定文字列でフィルターしたリストを表示。仕様名、プロバイダー名、タイプ名などでフィルターを指定して、リソースを表示できます。 |

6.3. リソース固有のパラメーター

リソースごとに以下のコマンドを使用すると、そのリソースに設定できるパラメーターが表示されます。

# pcs resource describe standard:provider:type|type

たとえば、以下のコマンドはタイプ

LVM のリソースに設定できるパラメーターを表示します。

# pcs resource describe LVM

Resource options for: LVM

volgrpname (required): The name of volume group.

exclusive: If set, the volume group will be activated exclusively.

partial_activation: If set, the volume group will be activated even

only partial of the physical volumes available. It helps to set to

true, when you are using mirroring logical volumes.

6.4. リソースのメタオプション

リソースには、リソース固有のパラメーターの他に、リソースオプションを設定できます。このような追加オプションは、クラスターがリソースの動作を決定する際に使用されます。表6.3「リソースのメタオプション」 では、このようなオプションを説明します。

| フィールド | デフォルト | 説明 |

|---|---|---|

priority

| 0

| |

target-role

| Started

|

クラスターが維持するリソースのステータスです。使用できる値は以下のようになります。

* Stopped - リソースの強制停止

* Started - リソースの起動を許可 (多状態リソースの場合マスターには昇格されません)

|

is-managed

| true

| |

resource-stickiness

|

0

| |

requires

|

Calculated

|

リソースを起動できる条件を示します。

以下の条件を除き、デフォルトでは

フェンシング に設定されます。以下の値が使用できます。

*

nothing - クラスターは常にリソースを起動できます。

*

quorum - クラスターは、設定されているノードの過半数がアクティブな場合にのみこのリソースを起動できます。stonith-enabled が false の場合、またはリソースの standard が stonith の場合は、この値になります。

*

fencing -設定されているノードの過半数がアクティブで 障害が発生しているノードや不明なノードの電源がすべてオフになっている場合にのみ、クラスターはこのリソースを起動できます。

|

migration-threshold

| INFINITY

|

指定したリソースが任意のノードで失敗した回数です。この回数を超えると、そのノードには、このリソースのホストとして不適格とするマークが付けられます。値 0 は、この機能が無効になっていることを示します(ノードは不適格としてマークされません)。一方、クラスターは

INFINITY (デフォルト)が非常に大きいものの、有限数として扱います。このオプションは、失敗した操作に on-fail=restart (デフォルト)があり、クラスタープロパティー start-failure-is-fatal が false の場合にのみ有効になります。migration-threshold オプションの設定の詳細は、「障害発生によるリソースの移動」 を参照してください。start-failure-is-fatal オプションの詳細は、表12.1「クラスターのプロパティー」 を参照してください。

|

failure-timeout

| 0 (無効)

| migration-threshold オプションと併用すると、障害が発生しなかったかのように動作し、障害が発生したノードにリソースを戻せるまで待機する秒数を示します。時間ベースのアクションと同様に、cluster-recheck-interval クラスターパラメーターの値よりも頻繁にチェックされる保証はありません。failure-timeout オプションの詳細は、「障害発生によるリソースの移動」 を参照してください。

|

multiple-active

| stop_start

|

リソースが複数のノードでアクティブであることが検出された場合に、クラスターが実行する動作です。使用できる値は以下のようになります。

*

block - リソースを unmanaged としてマークします。

*

stop_only - アクティブなインスタンスをすべて停止してそのままにします。

*

stop_start - すべてのアクティブなインスタンスを停止し、1 つの場所のみでリソースを起動します。

|

リソースオプションのデフォルト値を変更する場合は、次のコマンドを使用します。

pcs resource defaults options

たとえば、次のコマンドは、

resource-stickiness のデフォルト値を 100 にリセットします。

# pcs resource defaults resource-stickiness=100

pcs resource defaults で options パラメーターを省略すると、現在設定されているリソースオプションのデフォルト値のリストが表示されます。以下の例は、

resource-stickiness のデフォルト値を 100 にリセットした後のこのコマンドの出力を示しています。

# pcs resource defaults

resource-stickiness:100

リソースのメタオプションにおけるデフォルト値のリセットの有無に関わらず、リソースを作成する際に、特定リソースのリソースオプションをデフォルト以外の値に設定できます。以下は、リソースのメタオプションの値を指定するときに使用する

pcs resource create コマンドの形式です。

pcs resource create resource_id standard:provider:type|type [resource options] [meta meta_options...]

たとえば、以下のコマンドは

resource-stickiness の値を 50 にしてリソースを作成します。

# pcs resource create VirtualIP ocf:heartbeat:IPaddr2 ip=192.168.0.120 cidr_netmask=24 meta resource-stickiness=50

また、次のコマンドを使用すると既存のリソース、グループ、クローン作成したリソース、マスターリソースなどのリソースメタオプションの値を作成することもできます。

pcs resource meta resource_id | group_id | clone_id | master_id meta_options

以下の例では、

dummy_resource という名前の既存のリソースがあります。このコマンドは、failure-timeout メタオプションを 20 秒に設定し、同じノードで 20 秒で再起動を試行できるようにします。

# pcs resource meta dummy_resource failure-timeout=20s

このコマンドを実行すると、

failure-timeout=20s が設定されているか確認するためにリソースの値を表示できます。

# pcs resource show dummy_resource

Resource: dummy_resource (class=ocf provider=heartbeat type=Dummy)

Meta Attrs: failure-timeout=20s

Operations: start interval=0s timeout=20 (dummy_resource-start-timeout-20)

stop interval=0s timeout=20 (dummy_resource-stop-timeout-20)

monitor interval=10 timeout=20 (dummy_resource-monitor-interval-10)

リソースの clone メタオプションについては 「リソースのクローン」 を参照してください。リソースの master メタオプションについては 「多状態のリソース: 複数モードのリソース」 を参照してください。

6.5. リソースグループ

クラスターの最も一般的な設定要素の 1 つがリソースセットです。リソースセットはまとめて配置し、順番に起動し、その逆順で停止する必要があります。この設定を簡単にするため、 Pacemaker はグループの概念をサポートします。

以下のコマンドを使用してリソースグループを作成し、グループに追加するリソースを指定します。グループが存在しない場合は、このコマンドによりグループが作成されます。グループが存在する場合は、このコマンドにより別のリソースがグループに追加されます。リソースは、このコマンドで指定された順序で起動し、その逆順で停止します。

pcs resource group add group_name resource_id [resource_id] ... [resource_id] [--before resource_id | --after resource_id]

このコマンドの

--before オプションおよび --after オプションを使用して、追加するリソースの位置を、そのグループにすでに含まれるリソースを基準にして指定できます。

以下のコマンドを使用して、リソースを作成するときに、既存のグループに新しいリソースを追加することもできます。作成するリソースは group_name というグループに追加されます。

pcs resource create resource_id standard:provider:type|type [resource_options] [op operation_action operation_options] --group group_name

以下のコマンドを使用して、グループからリソースを削除します。グループにリソースがない場合、このコマンドはグループ自体を削除します。

pcs resource group remove group_name resource_id...

以下のコマンドは、現在設定されているリソースグループをリスト表示します。

pcs resource group list

以下の例では、既存のリソースの

IPaddr と Email が含まれるリソースグループ shortcut を作成します。

# pcs resource group add shortcut IPaddr Email

グループに含まれるリソースの数に制限はありません。グループの基本的なプロパティーは以下のとおりです。

- リソースは、指定した順序で起動します(この例では、最初に

IPaddr、次にEmail)。 - リソースは、指定した順序と逆の順序で停止します。(

電子メールを最初に、次にIPaddr)。

グループ内に実行できないリソースがあると、そのリソースの後に指定されたリソースは実行できません。

IPaddrを実行できない場合は、電子メールはできません。Emailを実行できなくても、IPaddrには影響を及ぼしません。

グループが大きくなると、リソースグループ作成の設定作業を軽減することが重要になります。

6.5.1. グループオプション

リソースグループは、含まれるリソースから

priority、target-role、is-managed オプションを継承します。リソースオプションの詳細は、表6.3「リソースのメタオプション」 を参照してください。

6.5.2. グループの Stickiness (粘着性)

粘着性は、リソースを現在の場所に留ませる優先度の度合いを示し、グループで加算されます。グループのアクティブなリソースが持つ stickness 値の合計が、グループの合計になります。したがって、デフォルトの

resource-stickiness が 100 で、グループに 7 つのメンバーがあり、そのうちの 5 つがアクティブな場合、グループ全体でスコアが 500 の現在の場所が優先されます。

6.6. リソースの動作

リソースの健全性を維持するために、リソースの定義に監視操作を追加することができます。リソースの監視操作を指定しないと、pcs コマンドによりデフォルトで監視動作が作成されます。この間隔は、リソースエージェントにより決定します。リソースエージェントでデフォルトの監視間隔が提供されない場合は、pcs コマンドにより 60 秒間隔の監視動作が作成されます。

表6.4「動作のプロパティー」 に、リソースの監視動作のプロパティーを示します。

6.6.1. リソース操作の設定

次のコマンドでリソースを作成すると、監視操作を設定できます。

pcs resource create resource_id standard:provider:type|type [resource_options] [op operation_action operation_options [operation_type operation_options]...]

たとえば、次のコマンドは、監視操作で

IPaddr2 リソースを作成します。新しいリソースは、eth2 で IP アドレス 192.168.0.99、ネットマスクが 24 の VirtualIP と呼ばれます。監視操作は、30 秒ごとに実施されます。

# pcs resource create VirtualIP ocf:heartbeat:IPaddr2 ip=192.168.0.99 cidr_netmask=24 nic=eth2 op monitor interval=30s

また、次のコマンドで既存のリソースに監視操作を追加することもできます。

pcs resource op add resource_id operation_action [operation_properties]

設定されているリソース操作を削除する場合は、次のコマンドを使用します。

pcs resource op remove resource_id operation_name operation_properties

注記

操作プロパティーを正しく指定して、既存の操作を適切に削除する必要があります。

監視オプションの値を変更する場合は、リソースを更新します。たとえば、以下のコマンドで

VirtualIP を作成できます。

# pcs resource create VirtualIP ocf:heartbeat:IPaddr2 ip=192.168.0.99 cidr_netmask=24 nic=eth2

デフォルトでは、次の操作が作成されます。

Operations: start interval=0s timeout=20s (VirtualIP-start-timeout-20s)

stop interval=0s timeout=20s (VirtualIP-stop-timeout-20s)

monitor interval=10s timeout=20s (VirtualIP-monitor-interval-10s)

stop の timeout 操作を変更するには、以下のコマンドを実行します。

#pcs resource update VirtualIP op stop interval=0s timeout=40s#pcs resource show VirtualIPResource: VirtualIP (class=ocf provider=heartbeat type=IPaddr2) Attributes: ip=192.168.0.99 cidr_netmask=24 nic=eth2 Operations: start interval=0s timeout=20s (VirtualIP-start-timeout-20s) monitor interval=10s timeout=20s (VirtualIP-monitor-interval-10s) stop interval=0s timeout=40s (VirtualIP-name-stop-interval-0s-timeout-40s)

注記

pcs resource update コマンドでリソースの操作を更新すると、特に呼び出しのないオプションはデフォルト値にリセットされます。

6.6.2. グローバルリソース操作のデフォルトの設定

次のコマンドを使用して、監視操作のグローバルデフォルト値を設定できます。

pcs resource op defaults [options]

たとえば、次のコマンドは、すべての監視操作に対して、

timeout 値のグローバルデフォルトを 240 秒に設定します。

# pcs resource op defaults timeout=240s

監視操作に現在設定されているデフォルト値を表示するには、オプションを指定せずに pcs resource op defaults コマンドを実行します。

たとえば、以下のコマンドは、

タイムアウト 値 240 秒で設定されたクラスターのデフォルトの監視操作値を表示します。

# pcs resource op defaults

timeout: 240s

クラスターリソース定義でオプションが指定されていない場合に限り、クラスターリソースがグローバルデフォルトを使用することに注意してください。デフォルトでは、リソースエージェントはすべての操作に

timeout オプションを定義します。グローバル操作のタイムアウト値を有効にするには、timeout オプションを明示的に指定せずにクラスターリソースを作成するか、以下のコマンドのように、クラスターリソースを更新して timeout オプションを削除する必要があります。

# pcs resource update VirtualIP op monitor interval=10s

たとえば、すべての監視操作にグローバルなデフォルトの

タイムアウト 値を 240 秒に設定し、クラスターリソース VirtualIP を更新して monitor 操作のタイムアウト値を削除すると、リソース VirtualIP には、start、stop、および monitor の操作のタイムアウト値がそれぞれ 20s、40s、および 240s になります。タイムアウト操作のグローバルデフォルト値は、ここでは monitor 操作にのみ適用されます。ここでは、前のコマンドでデフォルトの timeout オプションが削除されました。

# pcs resource show VirtualIP

Resource: VirtualIP (class=ocf provider=heartbeat type=IPaddr2)

Attributes: ip=192.168.0.99 cidr_netmask=24 nic=eth2

Operations: start interval=0s timeout=20s (VirtualIP-start-timeout-20s)

monitor interval=10s (VirtualIP-monitor-interval-10s)

stop interval=0s timeout=40s (VirtualIP-name-stop-interval-0s-timeout-40s)

6.7. 設定されているリソースの表示

設定されているリソースのリストを表示する場合は、次のコマンドを使用します。

pcs resource show

たとえば、システムが

VirtualIP という名前のリソースと WebSite という名前のリソースで設定されていると、pcs resource show コマンドを実行すると以下の出力が得られます。

# pcs resource show

VirtualIP (ocf::heartbeat:IPaddr2): Started

WebSite (ocf::heartbeat:apache): Started

リソースに設定されているパラメーターを表示する場合は、次のコマンドを使用します。

pcs resource show resource_id

たとえば、次のコマンドは、現在設定されているリソース

VirtualIP 用にパラメーターを表示します。

# pcs resource show VirtualIP

Resource: VirtualIP (type=IPaddr2 class=ocf provider=heartbeat)

Attributes: ip=192.168.0.120 cidr_netmask=24

Operations: monitor interval=30s

6.8. リソースパラメーターの変更

設定されているリソースのパラメーターを変更する場合は、次のコマンドを使用します。

pcs resource update resource_id [resource_options]

以下のコマンドシーケンスでは、

VirtualIP リソースに設定したパラメーターの初期値、ip パラメーターの値を変更するコマンド、update コマンドの後の値を示しています。

#pcs resource show VirtualIPResource: VirtualIP (type=IPaddr2 class=ocf provider=heartbeat) Attributes: ip=192.168.0.120 cidr_netmask=24 Operations: monitor interval=30s #pcs resource update VirtualIP ip=192.169.0.120#pcs resource show VirtualIPResource: VirtualIP (type=IPaddr2 class=ocf provider=heartbeat) Attributes: ip=192.169.0.120 cidr_netmask=24 Operations: monitor interval=30s

6.9. 複数のモニタリング動作

リソースエージェントが対応する範囲で、1 つのリソースに複数の監視操作を設定できます。これにより、1 分ごとに表面的なヘルスチェックを行い、徐々に頻度を上げてより正確なチェックを行うこともできます。

注記

複数の監視操作を設定する場合は、2 種類の操作が同じ間隔で実行されないように注意してください。

異なるレベルでの詳細なチェックに対応するリソースの追加監視操作を設定するには、

OCF_CHECK_LEVEL=n オプションを追加します。

たとえば、以下の

IPaddr2 リソースを設定すると、デフォルトで 10 秒間隔でタイムアウト値が 20 秒の監視操作が作成されます。

# pcs resource create VirtualIP ocf:heartbeat:IPaddr2 ip=192.168.0.99 cidr_netmask=24 nic=eth2

仮想 IP が、深さ 10 の様々なチェックに対応する場合は、次のコマンドを実行すると、Pacemaker は、通常の 10 秒間隔の仮想 IP チェックに加えて、60 秒ごとに高度な監視チェックを実行します。なお、上述のとおり、追加の監視操作は 10 秒間隔にしないようにしてください。

# pcs resource op add VirtualIP monitor interval=60s OCF_CHECK_LEVEL=106.10. クラスターリソースの有効化と無効化

以下のコマンドは、

resource_id で指定されるリソースを有効にします。

pcs resource enable resource_id

次のコマンドは、

resource_id で指定されるリソースを無効にします。

pcs resource disable resource_id6.11. クラスターリソースのクリーンアップ

リソースに障害が発生すると、クラスターの状態を表示するときに障害メッセージが表示されます。このリソースを解決する場合は、pcs resource cleanup コマンドで障害状態を消去できます。このコマンドは、リソースのステータスと

failcount をリセットし、リソースの操作履歴を取得し、現在の状態を再検出するようにクラスターに指示します。

以下のコマンドは、resource_id によって指定されたリソースをクリーンアップします。

pcs resource cleanup resource_id

resource_id を指定しないと、このコマンドはすべてのリソースのリソースステータスと

failcountをリセットします。

Red Hat Enterprise Linux 7.5 では、pcs resource cleanup コマンドは、失敗したアクションとして表示されるリソースのみを検証します。全ノードの全リソースを調査するには、次のコマンドを入力します。

pcs resource refresh

デフォルトでは、pcs resource refresh コマンドは、リソースの状態が分かっているノードだけを検証します。ステータスが分からないすべてのリソースを検証するには、以下のコマンドを実行します。

pcs resource refresh --full

第7章 リソースの制約

リソースの制約を設定して、クラスター内のそのリソースの動作を指定できます。以下の制約のカテゴリーを設定できます。

場所の制約 - リソースを実行できるノードを指定する場所の制約です。場所の制約については 「場所の制約」 で説明しています。順序の制約:順序制約により、リソースが実行される順序が決まります。順序の制約については 「順序の制約」 で説明しています。コロケーションの制約 - 他のリソースに対して相対的にリソースの配置先を決定します。コロケーションの制約については 「リソースのコロケーション」 で説明しています。

複数リソースをまとめて配置して、順番に起動するまたは逆順で停止する一連の制約を簡単に設定する方法として、Pacemaker ではリソースグループという概念に対応しています。リソースグループの詳細は 「リソースグループ」 を参照してください。

7.1. 場所の制約

場所の制約は、リソースを実行するノードを指定します。場所の制約を設定することで、たとえば特定のノードで優先してリソースを実行する、または特定のノードではリソースを実行しないことを決定できます。

場所の制約 に加え、リソースが実行されるノードは、そのリソースの

resource-stickiness 値の影響を受けます。これは、リソースが現在実行しているノードに留まることをどの程度優先するかを決定します。resource-stickiness 値の設定に関する詳細は、「現在のノードを優先させるリソースの設定」 を参照してください。

7.1.1. 基本的な場所の制約

基本的な場所の制約を設定して、リソースがノードを優先するか回避するかを指定できます。オプションの

score 値を使用して、制約の相対的な優先度を指定できます。

以下のコマンドは、リソースの実行を、指定した 1 つまたは複数のノードで優先するように、場所の制約を作成します。1 回のコマンドで、特定のリソースの制約を複数のノードに対して作成できます。

pcs constraint location rsc prefers node[=score] [node[=score]] ...

次のコマンドは、リソースが指定ノードを回避する場所の制約を作成します。

pcs constraint location rsc avoids node[=score] [node[=score]] ...

表7.1「簡単な場所の制約オプション」 では、最も簡単な形式で場所の制約を設定する場合のオプションの意味をまとめています。

| フィールド | 説明 |

|---|---|

rsc

|

リソース名

|

node

|

ノード名

|

score

|

リソースを特定ノードで優先的に実行するか、または実行を回避するかを示す正の整数値。

INFINITY は、リソースの場所制約のデフォルトの スコア 値です。

pcs contraint location rsc prefers コマンドで score の値の INFINITY を指定すると、そのノードが利用可能な場合は、リソースがそのノードで優先的に実行します。ただし、そのノードが利用できない場合に、別のノードでそのリソースを実行しないようにする訳ではありません。

pcs contraint location rsc avoids コマンドの score に INFINITY を指定すると、他のノードが利用できない場合でも、そのリソースはそのノードでは実行されないことを示します。これは、-INFINITY のスコアで pcs constraint location add コマンドを設定するのと同じです。

|

以下のコマンドは、

Webserver リソースが node1 ノードを優先するように指定する場所の制約を作成します。

# pcs constraint location Webserver prefers node1

Red Hat Enterprise Linux 7.4 では、pcs は、コマンドラインの場所の制約における正規表現に対応しています。この制約は、リソース名に一致する正規表現に基づいて、複数のリソースに適用されます。これにより、1 つのコマンドラインで複数の場所の制約を設定できます。

次のコマンドは、

dummy0 から dummy9 までのリソースが node1 を優先するように指定する場所の制約を作成します。

# pcs constraint location 'regexp%dummy[0-9]' prefers node1

Pacemaker は、 http://pubs.opengroup.org/onlinepubs/9699919799/basedefs/V1_chap09.html#tag_09_04 で説明しているように、POSIX 拡張正規表現を使用するため、以下のコマンドを実行しても同じ制約を指定できます。

# pcs constraint location 'regexp%dummy[[:digit:]]' prefers node17.1.2. 高度な場所の制約

ノードに場所の制約を設定する場合は、pcs constraint location コマンドの

resource-discovery オプションを使用して、指定したリソースに対して Pacemaker がこのノードでリソース検出を実行するかどうかの優先順位を指定できます。物理的にリソースが稼働可能なノードのサブセットでリソース検出を制限すると、ノードが大量に存在する場合にパフォーマンスを大幅に改善できます。pacemaker_remote を使用してノード数を数百のノード数に拡張する場合は、このオプションを考慮する必要があります。

以下のコマンドは、pcs constraint location コマンドで

resource-discovery オプションを指定するための形式を示しています。id は制約 id であることに注意してください。rsc、node、score の意味は 表7.1「簡単な場所の制約オプション」 で説明しています。このコマンドでは、基本的な場所の制約に対応します。score を正の値にすると、リソースが特定のノードで優先的に実行するように設定されます。score を負の値にすると、リソースがノードを回避するように設定されます。基本的な場所の制約と同様に、制約にリソースの正規表現を使用することもできます。

pcs constraint location add id rsc node score [resource-discovery=option]

表7.2「リソース検出の値」 では、

resource-discovery オプションに指定できる値を説明しています。

| 値 | 説明 |

|---|---|

always

|

このノードに指定したリソースで、リソース検出を常に実行します。これは、リソースの場所の制約のデフォルトの

resource-discovery 値です。

|

never

|

このノードで指定ししたリソースでのリソース検出は実行しません。

|

exclusive

|

指定したリソース(および

exclusiveとしてマークされている他のノード)でのみ、リソース検出を実行します。異なるノード間で同じリソースの exclusive 検出を使用する複数の場所制約により、resource-discovery が排他的なノードのサブセットが作成されます。リソースが 1 つ以上のノードの exclusive 検出用にマークされている場合、そのリソースは、そのノードのサブセット内にのみ配置できます。

|

resource-discovery オプションを never または exclusive に設定すると、クラスターが認識しなくても、該当する場所でリソースがアクティブになる可能性があることに注意してください。これにより、サービスがクラスター制御外( systemd または管理者など)以外で起動すると、複数の場所でリソースがアクティブになる可能性があります。これは、クラスターの一部がダウンしたりスプリットブレインが発生しているときに resource-discovery プロパティーが変更された場合や、そのノードでリソースがアクティブになっている間に resource-discovery プロパティーがリソースおよびノードのリソースに対して変更された場合にも発生する可能性があります。そのため、ノードの数が 9 以上で、特定の場所しかリソースを実行できない場合 (必要なソフトウェアが他の場所にインストールされていない場合など) に限り、このオプションは適しています。

7.1.3. ルールを使用したリソースの場所の確定

より複雑な場所の制約は、Pacemaker ルールを使用してリソースの場所を判断することができます。Pacemaker ルールや設定できるパロパティの概要は、11章Pacemaker ルール を参照してください。

以下のコマンドを使用して、ルールを使用する Pacemaker 制約を使用します。

score を省略すると、デフォルトで INFINITY に設定されます。resource-discovery を省略すると、デフォルトで always に設定されます。resource-discovery オプションの詳細は、「高度な場所の制約」 を参照してください。基本的な場所の制約と同様に、制約にリソースの正規表現を使用することもできます。

ルールを使用して場所の制約を設定する場合は、

score の値を正または負の値にすることができます。正の値は "prefers" を示し、負の値は "avoids" を示します。

pcs constraint location rsc rule [resource-discovery=option] [role=master|slave] [score=score | score-attribute=attribute] expression

expression オプションは、duration_options および date_spec_options のいずれかに設定できます。使用できる値は、表11.5「日付詳細のプロパティー」 で説明されているように、hours、monthdays、weekdays、yeardays、months、weeks、years、weekyears、moon になります。

defined|not_defined attributeattribute lt|gt|lte|gte|eq|ne [string|integer|version] valuedate gt|lt date日付範囲内の 日付date in-range date to duration duration_options ...date-spec date_spec_options式 および|or 式(expression)

以下の場所の制約は、現在が 2018 年の任意の時点である場合に true の式を設定します。

# pcs constraint location Webserver rule score=INFINITY date-spec years=2018

以下のコマンドは、月曜日から金曜日までの 9 am から 5 pm までが true となる式を設定します。hours の値 16 には、時間 (hour) の値が一致する 16:59:59 までが含まれます。

# pcs constraint location Webserver rule score=INFINITY date-spec hours="9-16" weekdays="1-5"

以下のコマンドは、13 日の金曜日が満月になると true になる式を設定します。

# pcs constraint location Webserver rule date-spec weekdays=5 monthdays=13 moon=47.1.4. 場所の制約ストラテジー

「基本的な場所の制約」、「高度な場所の制約」、「ルールを使用したリソースの場所の確定」 で説明している場所の制約のいずれかを使用することで、リソースを実行できるノードを指定するための一般的なストラテジーを設定できます。

- オプトインクラスター - デフォルトでは、すべてのリソースを、どのノードでも実行できません。そして、特定のリソースに対してノードを選択的に許可できるようにクラスターを設定します。オプトインクラスターの設定方法は 「オプトインクラスターの設定」 で説明しています。

- オプトアウトクラスター - デフォルトでは、すべてのリソースをどのノードでも実行できるクラスターを設定してから、リソースを特定のノードで実行しないように、場所の制約を作成します。オプトアウトクラスターの設定方法は 「オプトアウトクラスターの設定」 で説明しています。これは、デフォルトの Pacemaker ストラテジーです。

クラスターでオプトインまたはオプトアウトのどちらを選択するかは、独自に優先する設定やクラスターの設定により異なります。ほとんどのリソースをほとんどのノードで実行できるようにする場合は、オプトアウトを使用した方が設定しやすくなる可能性があります。ほとんどのリソースを、一部のノードでのみ実行する場合は、オプトインを使用した方が設定しやすくなる可能性があります。

7.1.4.1. オプトインクラスターの設定

オプトインクラスターを作成するには、クラスタープロパティー

symmetric-cluster を false に設定し、デフォルトでは、いずれの場所でもリソースが実行されないようにします。

# pcs property set symmetric-cluster=false

個々のリソースでノードを有効にします。以下のコマンドは、場所の制約を設定し、

Webserver リソースでは example-1 ノードが優先され、Database リソースでは example-2 ノードが優先され、優先ノードに障害が発生した場合は両方のリソースが example-3 ノードにフェイルオーバーできるようにします。オプトインクラスターに場所の制約を設定する場合は、スコアをゼロに設定すると、リソースに対してノードの優先や回避を指定せずに、リソースをノードで実行できます。

#pcs constraint location Webserver prefers example-1=200#pcs constraint location Webserver prefers example-3=0#pcs constraint location Database prefers example-2=200#pcs constraint location Database prefers example-3=0

7.1.4.2. オプトアウトクラスターの設定

オプトアウトクラスターを作成するには、

symmetric-cluster クラスタープロパティーを true に設定して、デフォルトですべてのリソースがどこでも実行できるようにします。

# pcs property set symmetric-cluster=true

以下のコマンドを実行すると、「オプトインクラスターの設定」 の例と同じ設定になります。すべてのノードのスコアが暗黙的スコアが 0 であるため、優先ノードに障害が発生した場合は、両方のリソースを

example-3 ノードにフェイルオーバーできます。

#pcs constraint location Webserver prefers example-1=200#pcs constraint location Webserver avoids example-2=INFINITY#pcs constraint location Database avoids example-1=INFINITY#pcs constraint location Database prefers example-2=200

INFINITY は、スコアのデフォルト値であるため、上記コマンドでは、スコアに INFINITY を指定する必要はないことに注意してください。

7.1.5. 現在のノードを優先させるリソースの設定

リソースには、「リソースのメタオプション」 で説明されているように、リソースの作成時にメタ属性として設定できる

resource-stickiness 値があります。resource-stickiness 値は、現在実行しているノード上にリソースが残す量を決定します。Pacemaker は、他の設定(場所の制約の score 値など)とともに resource-stickiness 値を考慮して、リソースを別のノードに移動するか、そのまま残すかを決定します。

デフォルトでは、

resource-stickiness の値が 0 の状態でリソースが作成されます。resource-stickiness が 0 に設定され、場所の制約がない Pacemaker のデフォルト動作では、クラスターノード間で均等に分散されるようにリソースを移動します。この設定では、正常なリソースの移動頻度が想定よりも増える可能性があります。この動作を防ぐには、デフォルトの resource-stickiness 値を 1 に設定します。このデフォルトはクラスター内のすべてのリソースに適用されます。この小さい値は、作成する他の制約で簡単に上書きできますが、Pacemaker がクラスター全体で正常なリソースを不必要に移動しないようにするには十分です。

以下のコマンドは、デフォルトの resource-stickiness 値を 1 に設定します。

# pcs resource defaults resource-stickiness=1resource-stickiness 値が設定されている場合、リソースは新たに追加されたノードに移動されません。この時点でリソースバランシングが必要な場合は、resource-stickiness の値を一時的に 0 に設定できます。

場所の制約スコアが resource-stickiness 値よりも高い場合、クラスターは正常なリソースを、場所の制約がポイントするノードに依然として移動する可能性があります。

Pacemaker がリソースの配置先を決定する方法の詳細は、「使用と配置ストラテジー」 を参照してください。

7.2. 順序の制約

順序の制約でリソースを実行する順序を指定します。

次のコマンドを使って順序の制約を設定します。

pcs constraint order [action] resource_id then [action] resource_id [options]

表7.3「順序の制約のプロパティー」 では順序の制約を設定する場合のプロパティーとオプションについて簡単に示します。

| フィールド | 説明 |

|---|---|

|

resource_id

|

動作を行うリソースの名前。

|

|

action

|

リソースで実行する動作。action プロパティーでは、以下の値が使用できます。

*

start - リソースを開始します。

*

stop - リソースを停止します。

*

promote - リソースをスレーブリソースからマスターリソースにプロモートします。

*

demote - マスターリソースからスレーブリソースにリソースをデモートします。

アクションを指定しないと、デフォルトのアクションは

start になります。マスターリソースとスレーブリソースについての詳細は 「多状態のリソース: 複数モードのリソース」 を参照してください。

|

kind オプション

|

制約の実施方法。

kind オプションでは、以下の値を使用できます。

*

オプション - 両方のリソースが指定されたアクションを実行する場合にのみ適用されます。オプションの順序は 「勧告的な順序付け」 を参照してください。

*

必須 - 常に(デフォルト値)1 番目に指定したリソースが停止している場合や起動できない場合は、2 番目に指定したリソースが停止します。必須の順序の詳細は、「強制的な順序付け」 を参照してください。

*

シリアル化 - 一連のリソースに対して、2 つの停止/開始アクションが同時に実行されないようにします。

|

対称 オプション

|

7.2.1. 強制的な順序付け

mandatory 制約では 1 番目に指定しているリソースが実行されない限り 2 番目に指定しているリソースは実行できません。これは、

kind オプションのデフォルト値です。デフォルト値のままにしておくと 1 番目に指定しているリソースの状態が変化した場合、2 番目に指定したリソー スが必ず反応するようになります。

- 1 番目に指定している実行中のリソースを停止すると、2 番目に指定しているリソースも停止されます (実行している場合)。

- 1 番目に指定している実行中のリソースが実行しておらず起動できない場合には、指定したリソースは (実行していれば) 停止します。

- 2 番目に指定しているリソースの実行中に 1 番目に指定しているリソースが再起動されると、2 番目に指定しているリソースが停止され再起動されます。

ただし、クラスターは、それぞれの状態変化に対応することに注意してください。2 番目のリソースで停止操作を開始する前に 1 番目のリソースが再起動し、起動状態にあると、2 番目のリソースを再起動する必要がありません。

7.2.2. 勧告的な順序付け

順序の制約に

kind=Optional オプションを指定すると、制約は任意と見なされ、両方のリソースが指定のアクションを実行する場合のみ適用されます。1 番目に指定しているリソースの状態を変更しても、2 番目に指定しているリソースには影響しません。

以下のコマンドは、

VirtualIP および dummy_resource という名前のリソースのアドバイザリーの順序制約を設定します。