セキュリティーの強化

Red Hat Enterprise Linux 9 システムのセキュリティー強化

概要

Red Hat ドキュメントへのフィードバック (英語のみ)

Red Hat ドキュメントに関するご意見やご感想をお寄せください。また、改善点があればお知らせください。

Jira からのフィードバック送信 (アカウントが必要)

- Jira の Web サイトにログインします。

- 上部のナビゲーションバーで Create をクリックします。

- Summary フィールドにわかりやすいタイトルを入力します。

- Description フィールドに、ドキュメントの改善に関するご意見を記入してください。ドキュメントの該当部分へのリンクも追加してください。

- ダイアログの下部にある Create をクリックします。

第1章 インストール中およびインストール直後の RHEL の保護

セキュリティーへの対応は、Red Hat Enterprise Linux をインストールする前にすでに始まっています。最初からシステムのセキュリティーを設定することで、追加のセキュリティー設定を実装することがより簡単になります。

1.1. ディスクパーティション設定

ディスクパーティション設定の推奨プラクティスは、ベアメタルマシンへのインストールと、インストール済みオペレーティングシステムを含む仮想ディスクハードウェアおよびファイルシステムの調整をサポートする仮想化環境またはクラウド環境とでは異なります。

ベアメタルインストール でデータの分離と保護を確実に行うには、/boot、/、/home、/tmp、/var/tmp/ ディレクトリー用に個別のパーティションを作成します。

/boot-

このパーティションは、システムの起動時にシステムが最初に読み込むパーティションです。RHEL 9 でシステムを起動するのに使用するブートローダーとカーネルイメージはこのパーティションに保存されます。このパーティションは暗号化しないでください。このパーティションが

/に含まれており、そのパーティションが暗号化されているなどの理由で利用できなくなると、システムを起動できなくなります。 /home-

ユーザーデータ (

/home) が別のパーティションではなく/に保存されていると、このパーティションが満杯になり、オペレーティングシステムが不安定になる可能性があります。また、システムを、RHEL 9 の次のバージョンにアップグレードする際に、/homeパーティションにデータを保存できると、このデータはインストール時に上書きされないため、アップグレードが非常に簡単になります。root パーティション (/) が破損すると、データが完全に失われます。したがって、パーティションを分けることが、データ損失に対する保護につながります。また、このパーティションを、頻繁にバックアップを作成する対象にすることも可能です。 /tmpおよび/var/tmp/-

/tmpディレクトリーおよび/var/tmp/ディレクトリーは、どちらも長期保存の必要がないデータを保存するために使用されます。しかし、このいずれかのディレクトリーでデータがあふれると、ストレージ領域がすべて使用されてしまう可能性があります。このディレクトリーは/に置かれているため、こうした状態が発生すると、システムが不安定になり、クラッシュする可能性があります。そのため、このディレクトリーは個別のパーティションに移動することが推奨されます。

仮想マシンまたはクラウドインスタンス の場合、/boot、/home、/tmp、および /var/tmp パーティションの分離は任意です。/ パーティションがいっぱいになり始めたら、仮想ディスクのサイズとそのパーティションを拡張できるためです。/ パーティションがいっぱいにならないように、その使用状況を定期的にチェックするモニタリングを設定してから、仮想ディスクのサイズを適宜拡張してください。

インストールプロセス時に、パーティションを暗号化するオプションがあります。パスフレーズを入力する必要があります。これは、パーティションのデータを保護するのに使用されるバルク暗号鍵を解除する鍵として使用されます。

1.2. インストールプロセス時のネットワーク接続の制限

RHEL9 をインストールする際に使用するインストールメディアは、特定のタイミングで作成されたスナップショットです。そのため、セキュリティー修正が最新のものではなく、このインストールメディアで設定するシステムが公開されてから修正された特定の問題に対して安全性に欠ける場合があります。

脆弱性が含まれる可能性のあるオペレーティングシステムをインストールする場合には、必ず、公開レベルを、必要最小限のネットワークゾーンに限定してください。最も安全な選択肢は、インストールプロセス時にマシンをネットワークから切断した状態にする “ネットワークなし” ゾーンです。インターネット接続からのリスクが最も高く、一方で LAN またはイントラネット接続で十分な場合もあります。セキュリティーのベストプラクティスに従い、ネットワークから RHEL 9 をインストールする場合は、お使いのリポジトリーに最も近いゾーンを選択してください。

1.3. 必要なパッケージの最小限のインストール

コンピューターの各ソフトウェアには脆弱性が潜んでいる可能性があるため、実際に使用するパッケージのみをインストールすることがベストプラクティスになります。インストールを DVD から行う場合は、インストールしたいパッケージのみを選択するようにします。その他のパッケージが必要になる場合は、後でいつでもシステムに追加できます。

1.4. インストール後の手順

以下は、RHEL 9 のインストール直後に実行する必要があるセキュリティー関連の手順です。

システムを更新します。root で以下のコマンドを実行します。

dnf update

# dnf updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow ファイアウォールサービスの

firewalldは、Red Hat Enterprise Linux のインストールによって自動的に有効になりますが、キックスタート設定などで明示的に無効になっている場合があります。このような場合は、ファイアウォールを再度有効にしてください。firewalldを開始するには、root で次のコマンドを実行します。systemctl start firewalld systemctl enable firewalld

# systemctl start firewalld # systemctl enable firewalldCopy to Clipboard Copied! Toggle word wrap Toggle overflow セキュリティーを強化するために、不要なサービスは無効にしてください。たとえば、コンピューターにプリンターがインストールされていない場合は、次のコマンドを使用して、

cupsサービスを無効にします。systemctl disable cups

# systemctl disable cupsCopy to Clipboard Copied! Toggle word wrap Toggle overflow アクティブなサービスを確認するには、次のコマンドを実行します。

systemctl list-units | grep service

$ systemctl list-units | grep serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.5. Web コンソールを使用して CPU のセキュリティーの問題を防ぐために SMT を無効化する手順

CPU SMT (Simultaneous Multi Threading) を悪用する攻撃が発生した場合に SMT を無効にします。SMT を無効にすると、L1TF や MDS などのセキュリティー脆弱性を軽減できます。

SMT を無効にすると、システムパフォーマンスが低下する可能性があります。

前提条件

- RHEL 9 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

手順

RHEL 9 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

- Overview タブで、System information フィールドを見つけて、View hardware details をクリックします。

CPU Security 行で、Mitigations をクリックします。

このリンクがない場合は、システムが SMT に対応していないため、攻撃を受けません。

- CPU Security Toggles テーブルで、Disable simultaneous multithreading (nosmt) オプションに切り替えます。

- ボタンをクリックします。

システムの再起動後、CPU は SMT を使用しなくなりました。

第2章 FIPS モードへの RHEL の切り替え

連邦情報処理標準 (FIPS) 140-3 で義務付けられている暗号化モジュールの自己チェックを有効にするには、FIPS モードで RHEL 9 を操作する必要があります。FIPS 準拠を目指す場合は、FIPS モードでインストールを開始することを推奨します。

暗号化モジュールの検証ステータスは、Red Hat カスタマーポータルの Product compliance ページの FIPS - Federal Information Processing Standards セクションで確認できます。

2.1. Federal Information Processing Standards 140 および FIPS モード

Federal Information Processing Standards (FIPS) Publication 140 は、暗号化モジュールの品質を確保するために National Institute of Standards and Technology (NIST) によって開発された一連のコンピューターセキュリティー標準です。FIPS 140 標準は、暗号化ツールがアルゴリズムを正しく実装できるようにします。ランタイム暗号アルゴリズムと整合性セルフテストは、システムが標準の要件を満たす暗号を使用していることを確認するためのメカニズムの一部です。

FIPS モードの RHEL

RHEL システムで FIPS 承認のアルゴリズムだけを使用してすべての暗号鍵を生成および使用するには、RHEL を FIPS モードに切り替える必要があります。

次のいずれかの方法を使用して、FIPS モードを有効にできます。

- FIPS モードでのインストールの開始

- インストール後に FIPS モードにシステムを切り替えます。

FIPS 準拠を目指す場合は、FIPS モードでインストールを開始してください。これにより、デプロイ済みのシステムの変換に伴う暗号鍵マテリアルの再生成と、変換後のシステムのコンプライアンス再評価を行う必要がなくなります。

FIPS 準拠のシステムを運用するには、すべての暗号化キーマテリアルを FIPS モードで作成します。さらに、暗号鍵マテリアルは、セキュアにラップされていない限り、絶対に FIPS 環境の外部に出さないでください。また、絶対に FIPS 以外の環境でラップを解除しないでください。

Red Hat カスタマーポータルの Product compliance ページの FIPS - Federal Information Processing Standards セクションで、選択した RHEL マイナーリリースの暗号化モジュール検証ステータスの概要を確認できます。

インストール後に FIPS モードに切り替える

fips-mode-setup ツールを使用してシステムを FIPS モードに切り替えても、FIPS 140 標準への準拠は保証されません。システムを FIPS モードに設定した後にすべての暗号キーを再生成することは、可能でない場合があります。たとえば、ユーザーの暗号キーを含む既存の IdM レルムの場合、すべてのキーを再生成することはできません。FIPS モードでインストールを開始できない場合は、インストール後の設定手順を実行したり、ワークロードをインストールしたりする前に、インストール後の最初の手順として常に FIPS モードを有効にしてください。

fips-mode-setup ツールも内部的に FIPS システム全体の暗号化ポリシーを使用します。ただし、update-crypto-policies --set FIPS コマンドが実行する内容に加え、fips-mode-setup は、fips-finish-install ツールを使用して FIPS dracut モジュールを確実にインストールします。また、fips=1 ブートオプションをカーネルコマンドラインに追加し、初期 RAM ディスクを再生成します。

さらに、FIPS モードで必要な制限の適用は、/proc/sys/crypto/fips_enabled ファイルの内容によって異なります。ファイルに 1 が含まれている場合、RHEL コア暗号化コンポーネントは、FIPS 承認の暗号化アルゴリズムの実装のみを使用するモードに切り替わります。/proc/sys/crypto/fips_enabled に 0 が含まれている場合、暗号化コンポーネントは FIPS モードを有効にしません。

暗号化ポリシーにおける FIPS

FIPS システム全体の暗号化ポリシーは、より高いレベルの制限を設定するのに役立ちます。したがって、暗号化の俊敏性をサポートする通信プロトコルは、選択時にシステムが拒否する暗号をアナウンスしません。たとえば、ChaCha20 アルゴリズムは FIPS によって承認されておらず、FIPS 暗号化ポリシーは、TLS サーバーおよびクライアントが TLS_ECDHE_ECDSA_WITH_CHACHA20_POLY1305_SHA256 TLS 暗号スイートをアナウンスしないようにします。これは、そのような暗号を使用しようとすると失敗するためです。

RHEL を FIPS モードで操作し、独自の FIPS モード関連の設定オプションを提供するアプリケーションを使用する場合は、これらのオプションと対応するアプリケーションのガイダンスを無視してください。FIPS モードで実行されているシステムとシステム全体の暗号化ポリシーは、FIPS 準拠の暗号化のみを適用します。たとえば、システムが FIPS モードで実行されている場合、Node.js 設定オプション --enable-fips は無視されます。FIPS モードで実行されていないシステムで --enable-fips オプションを使用すると、FIPS-140 準拠の要件を満たせなくなります。

FIPS モードで実行されている RHEL 9.2 以降のシステムでは、FIPS 140-3 標準の要件に従って、TLS 1.2 接続で Extended Master Secret (EMS) 拡張機能 (RFC 7627) を使用する必要があります。したがって、EMS または TLS 1.3 をサポートしていないレガシークライアントは、FIPS モードで実行されている RHEL 9 サーバーに接続できません。FIPS モードの RHEL 9 クライアントは、EMS なしで TLS 1.2 のみをサポートするサーバーに接続できません。詳細は、Red Hat ナレッジベースのソリューション TLS Extension "Extended Master Secret" enforced with Red Hat Enterprise Linux 9.2 を参照してください。

2.2. FIPS モードが有効なシステムのインストール

連邦情報処理規格 (FIPS) 140 で義務付けられている暗号化モジュールの自己チェックを有効にするには、システムのインストール時に FIPS モードを有効にします。

RHEL のインストール中に FIPS モードを有効にするだけで、システムは FIPS で承認されるアルゴリズムと継続的な監視テストですべての鍵を生成するようになります。

FIPS モードのセットアップを完了した後、FIPS モードをオフにすると、システムが必ず不整合な状態になります。このような変更が必要な場合、システムを完全に再インストールするのが唯一の正しい方法です。

手順

-

システムのインストール時に

fips=1オプションをカーネルコマンドラインに追加します。 - ソフトウェアの選択段階で、サードパーティーのソフトウェアをインストールしないでください。

- インストール後に、システムは FIPS モードで自動的に起動します。

検証

システムが起動したら、FIPS モードが有効になっていることを確認します。

fips-mode-setup --check FIPS mode is enabled.

$ fips-mode-setup --check FIPS mode is enabled.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. FIPS モードへのシステムの切り替え

システム全体の暗号化ポリシーには、連邦情報処理標準 (FIPS) Publication 140 の要件に従って暗号化アルゴリズムを有効にするポリシーレベルが含まれています。FIPS モードを有効または無効にする fips-mode-setup ツールは、内部的に FIPS のシステム全体の暗号化ポリシーを使用します。

FIPS システム全体の暗号化ポリシーを使用してシステムを FIPS モードに切り替えても、FIPS 140 標準への準拠は保証されません。システムを FIPS モードに設定した後にすべての暗号キーを再生成することは、可能でない場合があります。たとえば、ユーザーの暗号キーを含む既存の IdM レルムの場合、すべてのキーを再生成することはできません。

RHEL のインストール中に FIPS モード を有効にするだけで、システムは FIPS で承認されるアルゴリズムと継続的な監視テストですべてのキーを生成するようになります。

fips-mode-setup ツールは、FIPS ポリシーを内部的に使用します。ただし、--set FIPS オプションを指定した update-crypto-policies コマンドが実行する内容に加え、fips-mode-setup は、fips-finish-install ツールを使用して FIPS dracut モジュールを確実にインストールします。また、fips=1 ブートオプションをカーネルコマンドラインに追加し、初期 RAM ディスクを再生成します。

FIPS モードのセットアップを完了した後、FIPS モードをオフにすると、システムが必ず不整合な状態になります。このような変更が必要な場合、システムを完全に再インストールするのが唯一の正しい方法です。

手順

システムを FIPS モードに切り替えるには、以下のコマンドを実行します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow システムを再起動して、カーネルを FIPS モードに切り替えます。

reboot

# rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

システムが再起動したら、FIPS モードの現在の状態を確認できます。

fips-mode-setup --check FIPS mode is enabled.

# fips-mode-setup --check FIPS mode is enabled.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4. コンテナーでの FIPS モードの有効化

Federal Information Processing Standard Publication 140-2 (FIPS モード) で義務付けられている暗号化モジュールのセルフチェックの完全なセットを有効にするには、ホストシステムのカーネルが FIPS モードで実行されている必要があります。podman ユーティリティーは、サポートされているコンテナーで FIPS モードを自動的に有効にします。

コンテナーで fips-mode-setup コマンドが正しく機能せず、このシナリオでこのコマンドを使用して FIPS モードを有効にしたり確認することができません。

前提条件

- ホストシステムが FIPS モードである必要があります。

手順

-

FIPS モードが有効になっているシステムでは、

podmanユーティリティーはサポートされているコンテナーで FIPS モードを自動的に有効にします。

2.5. FIPS 140-3 に準拠していない暗号化を使用している RHEL アプリケーションのリスト

FIPS 140-3 などの関連するすべての暗号化認定に合格するには、コア暗号化コンポーネントセットのライブラリーを使用します。これらのライブラリーは、libgcrypt を除き、RHEL システム全体の暗号化ポリシーに従います。

コア暗号化コンポーネントの概要、そのコンポーネントの選択方法、オペレーティングシステムへの統合方法、ハードウェアセキュリティーモジュールおよびスマートカードのサポート方法、暗号化による認定の適用方法の概要は、Red Hat ナレッジベースの記事 RHEL core cryptographic components を参照してください。

FIPS 140-3 に準拠していない暗号化を使用している RHEL 9 アプリケーションのリスト

- Bacula

- CRAM-MD5 認証プロトコルを実装します。

- Cyrus SASL

- SCRAM-SHA-1 認証方式を使用します。

- Dovecot

- SCRAM-SHA-1 を使用します。

- Emacs

- SCRAM-SHA-1 を使用します。

- FreeRADIUS

- 認証プロトコルに MD5 および SHA-1 を使用します。

- Ghostscript

- ドキュメントを暗号化および復号化するためのカスタムの cryptography 実装 (MD5、RC4、SHA-2、AES)

- GRUB

-

SHA-1 を必要とするレガシーファームウェアプロトコルをサポートし、

libgcryptライブラリーを含みます。 - iPXE

- TLS スタックを実装します。

- Kerberos

- SHA-1 (Windows との相互運用性) のサポートを維持します。

- Lasso

-

lasso_wsse_username_token_derive_key ()鍵導出関数 (KDF) は SHA-1 を使用します。 - MariaDB、MariaDB コネクター

-

mysql_native_password認証プラグインは SHA-1 を使用します。 - MySQL

-

mysql_native_passwordは SHA-1 を使用します。 - OpenIPMI

- RAKP-HMAC-MD5 認証方式は、FIPS の使用が承認されておらず、FIPS モードでは機能しません。

- OVMF (UEFI ファームウェア)、Edk2、shim

- 完全な暗号スタック (OpenSSL ライブラリーの埋め込みコピー)。

- Perl

- HMAC、HMAC-SHA1、HMAC-MD5、SHA-1、SHA-224 などを使用します。

- Pidgin

- DES および RC4 暗号を実装します。

- PKCS #12 ファイル処理 (OpenSSL、GnuTLS、NSS、Firefox、Java)

- ファイル全体の HMAC の計算に使用されるキー派生関数 (KDF) が FIPS で承認されていないため、PKCS #12 のすべての使用は FIPS に準拠していません。そのため、PKCS #12 ファイルは、FIPS 準拠のためにプレーンテキストと見なされます。鍵転送の目的で、FIPS 承認の暗号化方式を使用して PKCS #12 (.p12) ファイルをラップします。

- Poppler

- 元の PDF (MD5、RC4、SHA-1 など) に存在する場合は、許可されていないアルゴリズムに基づいて署名、パスワード、および暗号化を使用して PDF を保存できます。

- PostgreSQL

- Blowfish、DES、MD5 を実装します。KDF は SHA-1 を使用します。

- QAT エンジン

- 暗号化プリミティブのハードウェアおよびソフトウェア実装 (RSA、EC、DH、AES、…)

- Ruby

- 安全でないライブラリー関数 MD5 および SHA-1 を提供します。

- Samba

- RC4 および DES (Windows との相互運用性) のサポートを維持します。

- Syslinux

- BIOS パスワードは SHA-1 を使用します。

- SWTPM

- OpenSSL の使用時に FIPS モードを明示的に無効にします。

- Unbound

- DNS 仕様では、DNSSEC リゾルバーが検証のために DNSKEY レコードで SHA-1 ベースのアルゴリズムを使用する必要があります。

- Valgrind

- AES、SHA ハッシュ。[1]

- zip

- パスワードを使用してアーカイブを暗号化および復号化するためのカスタム暗号化実装 (セキュアでない PKWARE 暗号化アルゴリズム)。

第3章 システム全体の暗号化ポリシーの使用

システム全体の暗号化ポリシーは、コア暗号化サブシステムを設定するシステムコンポーネントで、TLS、IPsec、SSH、DNSSec、および Kerberos の各プロトコルに対応します。これにより、管理者が選択できる小規模セットのポリシーを提供します。

3.1. システム全体の暗号化ポリシー

システム全体のポリシーを設定すると、RHEL のアプリケーションはそのポリシーに従い、ポリシーを満たしていないアルゴリズムやプロトコルを使用するように明示的に要求されない限り、その使用を拒否します。つまり、システムが提供した設定で実行する際に、デフォルトのアプリケーションの挙動にポリシーを適用しますが、必要な場合は上書きできます。

RHEL 9 には、以下の定義済みポリシーが含まれています。

DEFAULT- デフォルトのシステム全体の暗号化ポリシーレベルで、現在の脅威モデルに対して安全なものです。TLS プロトコルの 1.2 と 1.3、IKEv2 プロトコル、および SSH2 プロトコルが使用できます。RSA 鍵と Diffie-Hellman パラメーターは長さが 2048 ビット以上であれば許容されます。

LEGACY- Red Hat Enterprise Linux 6 以前との互換性を最大限に確保します。攻撃対象領域が増えるため、セキュリティーが低下します。SHA-1 は、TLS ハッシュ、署名、およびアルゴリズムとして使用できます。CBC モードの暗号は、SSH と併用できます。GnuTLS を使用するアプリケーションは、SHA-1 で署名した証明書を許可します。TLS プロトコルの 1.2 と 1.3、IKEv2 プロトコル、および SSH2 プロトコルが使用できます。RSA 鍵と Diffie-Hellman パラメーターは長さが 2048 ビット以上であれば許容されます。

FUTURE将来の潜在的なポリシーをテストすることを目的とした、より厳格な将来を見据えたセキュリティーレベル。このポリシーでは、DNSSec または HMAC としての SHA-1 の使用は許可されません。SHA2-224 および SHA3-224 ハッシュは拒否されます。128 ビット暗号は無効になります。CBC モードの暗号は、Kerberos を除き無効になります。TLS プロトコルの 1.2 と 1.3、IKEv2 プロトコル、および SSH2 プロトコルが使用できます。RSA 鍵と Diffie-Hellman パラメーターは、ビット長が 3072 以上だと許可されます。システムが公共のインターネット上で通信する場合、相互運用性の問題が発生する可能性があります。

重要カスタマーポータル API の証明書が使用する暗号化鍵は

FUTUREのシステム全体の暗号化ポリシーが定義する要件を満たさないので、現時点でredhat-support-toolユーティリティーは、このポリシーレベルでは機能しません。この問題を回避するには、カスタマーポータル API への接続中に

DEFAULT暗号化ポリシーを使用します。FIPSFIPS 140 要件に準拠します。RHEL システムを FIPS モードに切り替える

fips-mode-setupツールは、このポリシーを内部的に使用します。FIPSポリシーに切り替えても、FIPS 140 標準への準拠は保証されません。また、システムを FIPS モードに設定した後、すべての暗号キーを再生成する必要があります。多くのシナリオでは、これは不可能です。また、RHEL はシステム全体のサブポリシー

FIPS:OSPPを提供します。これには、Common Criteria (CC) 認証に必要な暗号化アルゴリズムに関する追加の制限が含まれています。このサブポリシーを設定すると、システムの相互運用性が低下します。たとえば、3072 ビットより短い RSA 鍵と DH 鍵、追加の SSH アルゴリズム、および複数の TLS グループを使用できません。また、FIPS:OSPPを設定すると、Red Hat コンテンツ配信ネットワーク (CDN) 構造への接続が防止されます。さらに、FIPS:OSPPを使用する IdM デプロイメントには Active Directory (AD) を統合できません。FIPS:OSPPを使用する RHEL ホストと AD ドメイン間の通信が機能しないか、一部の AD アカウントが認証できない可能性があります。注記FIPS:OSPP暗号化サブポリシーを設定すると、システムが CC 非準拠になります。RHEL システムを CC 標準に準拠させる唯一の正しい方法は、cc-configパッケージで提供されているガイダンスに従うことです。認定済み RHEL バージョン、検証レポート、CC ガイドへのリンクのリストについては、Red Hat カスタマーポータルの Product compliance ページの Common Criteria セクションを参照してください。

Red Hat は、LEGACY ポリシーを使用する場合を除き、すべてのライブラリーがセキュアなデフォルト値を提供するように、すべてのポリシーレベルを継続的に調整します。LEGACY プロファイルはセキュアなデフォルト値を提供しませんが、このプロファイルには、簡単に悪用できるアルゴリズムは含まれていません。このため、提供されたポリシーで有効なアルゴリズムのセットまたは許容可能な鍵サイズは、Red Hat Enterprise Linux の存続期間中に変更する可能性があります。

このような変更は、新しいセキュリティー標準や新しいセキュリティー調査を反映しています。Red Hat Enterprise Linux のライフサイクル全体にわたって特定のシステムとの相互運用性を確保する必要がある場合は、そのシステムと対話するコンポーネントのシステム全体の暗号化ポリシーからオプトアウトするか、カスタム暗号化ポリシーを使用して特定のアルゴリズムを再度有効にする必要があります。

ポリシーレベルで許可されていると記載されている特定のアルゴリズムと暗号は、アプリケーションがそれらをサポートしている場合にのみ使用できます。

LEGACY | DEFAULT | FIPS | FUTURE | |

|---|---|---|---|---|

| IKEv1 | いいえ | いいえ | いいえ | いいえ |

| 3DES | いいえ | いいえ | いいえ | いいえ |

| RC4 | いいえ | いいえ | いいえ | いいえ |

| DH | 最低 2048 ビット | 最低 2048 ビット | 最低 2048 ビット | 最低 3072 ビット |

| RSA | 最低 2048 ビット | 最低 2048 ビット | 最低 2048 ビット | 最低 3072 ビット |

| DSA | いいえ | いいえ | いいえ | いいえ |

| TLS v1.1 以前 | いいえ | いいえ | いいえ | いいえ |

| TLS v1.2 以降 | はい | はい | はい | はい |

| デジタル署名および証明書の SHA-1 | はい | いいえ | いいえ | いいえ |

| CBC モード暗号 | はい | いいえ[a] | いいえ[b] | いいえ[c] |

| 256 ビットより小さい鍵を持つ対称暗号 | はい | はい | はい | いいえ |

[a]

CBC 暗号は SSH で無効になります。

[b]

CBC 暗号は、Kerberos を除くすべてのプロトコルで無効になります。

[c]

CBC 暗号は、Kerberos を除くすべてのプロトコルで無効になります。

| ||||

3.2. システム全体の暗号化ポリシーの変更

update-crypto-policies ツールを使用してシステムを再起動すると、システム全体の暗号化ポリシーを変更できます。

前提条件

- システムの root 権限がある。

手順

オプション: 現在の暗号化ポリシーを表示します。

update-crypto-policies --show DEFAULT

$ update-crypto-policies --show DEFAULTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 新しい暗号化ポリシーを設定します。

update-crypto-policies --set <POLICY> <POLICY>

# update-crypto-policies --set <POLICY> <POLICY>Copy to Clipboard Copied! Toggle word wrap Toggle overflow <POLICY>は、設定するポリシーまたはサブポリシー (FUTURE、LEGACY、FIPS:OSPPなど) に置き換えます。システムを再起動します。

reboot

# rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

現在の暗号化ポリシーを表示します。

update-crypto-policies --show <POLICY>

$ update-crypto-policies --show <POLICY>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3. システム全体の暗号化ポリシーを以前のリリースと互換性のあるモードに切り替える

Red Hat Enterprise Linux 9 におけるデフォルトのシステム全体の暗号化ポリシーでは、現在は古くて安全ではないプロトコルは許可されません。Red Hat Enterprise Linux 6 およびそれ以前のリリースとの互換性が必要な場合には、安全でない LEGACY ポリシーレベルを利用できます。

LEGACY ポリシーレベルに設定すると、システムおよびアプリケーションの安全性が低下します。

手順

システム全体の暗号化ポリシーを

LEGACYレベルに切り替えるには、rootで以下のコマンドを実行します。update-crypto-policies --set LEGACY Setting system policy to LEGACY

# update-crypto-policies --set LEGACY Setting system policy to LEGACYCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4. SHA-1 を再度有効に

署名を作成および検証するための SHA-1 アルゴリズムの使用は、DEFAULT 暗号化ポリシーで制限されています。シナリオで既存またはサードパーティーの暗号署名を検証するために SHA-1 を使用する必要がある場合は、RHEL 9 がデフォルトで提供する SHA1 サブポリシーを適用することで有効にできます。システムのセキュリティーが弱くなることに注意してください。

前提条件

-

このシステムは、

DEFAULTシステム全体の暗号化ポリシーを使用します。

手順

SHA1サブポリシーをDEFAULT暗号化ポリシーに適用します。update-crypto-policies --set DEFAULT:SHA1 Setting system policy to DEFAULT:SHA1 Note: System-wide crypto policies are applied on application start-up. It is recommended to restart the system for the change of policies to fully take place.

# update-crypto-policies --set DEFAULT:SHA1 Setting system policy to DEFAULT:SHA1 Note: System-wide crypto policies are applied on application start-up. It is recommended to restart the system for the change of policies to fully take place.Copy to Clipboard Copied! Toggle word wrap Toggle overflow システムを再起動します。

reboot

# rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

現在の暗号化ポリシーを表示します。

update-crypto-policies --show DEFAULT:SHA1

# update-crypto-policies --show DEFAULT:SHA1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

update-crypto-policies --set LEGACY コマンドを使用して LEGACY 暗号化ポリシーに切り替えると、署名に対して SHA-1 も有効になります。ただし、LEGACY 暗号化ポリシーは、他の弱い暗号化アルゴリズムも有効にすることで、システムをはるかに脆弱にします。この回避策は、SHA-1 署名以外のレガシー暗号化アルゴリズムを有効にする必要があるシナリオでのみ使用してください。

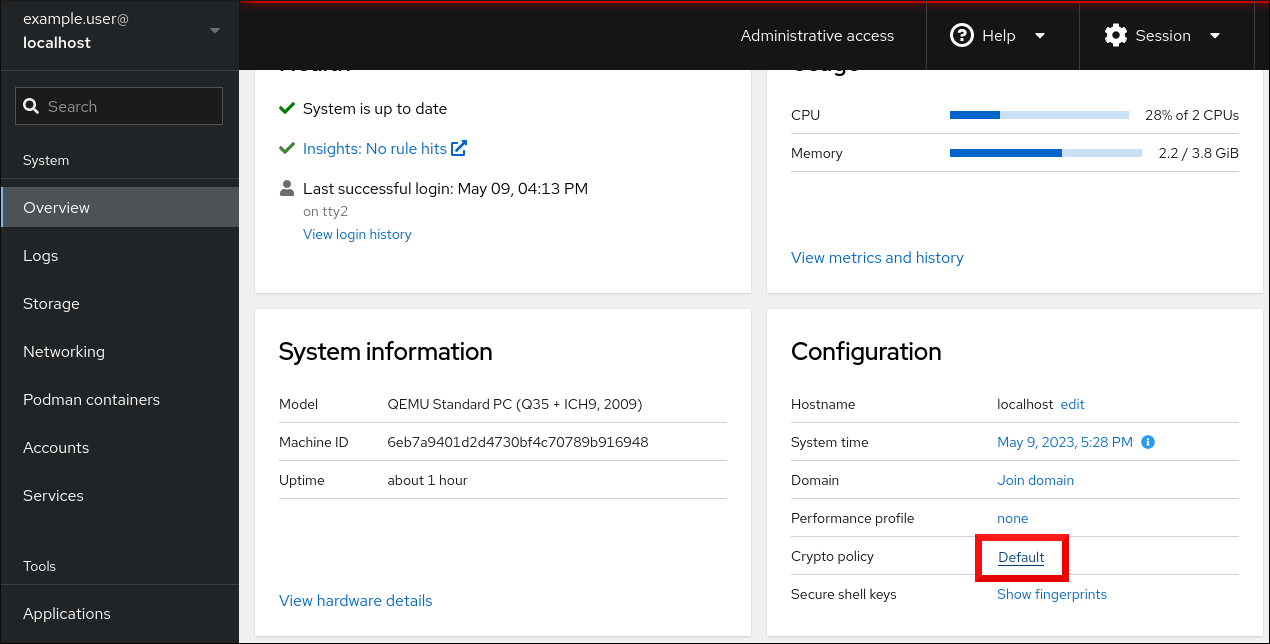

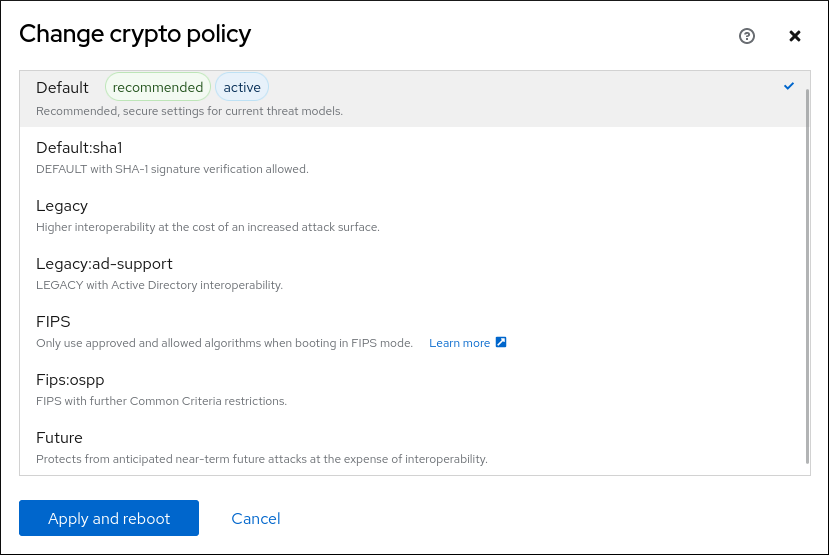

3.5. Web コンソールでシステム全体の暗号化ポリシーを設定する

RHEL Web コンソールインターフェイスで、システム全体の暗号化ポリシーとサブポリシーのいずれかを直接設定できます。4 つの事前定義されたシステム全体の暗号化ポリシーに加え、グラフィカルインターフェイスを介して、次のポリシーとサブポリシーの組み合わせを適用することもできます。

DEFAULT:SHA1-

SHA-1アルゴリズムが有効になっているDEFAULTポリシー。 LEGACY:AD-SUPPORT-

Active Directory サービスの相互運用性を向上させる、セキュリティーの低い設定を含む

LEGACYポリシー。 FIPS:OSPP-

Common Criteria for Information Technology Security Evaluation 標準によって要求される追加の制限を含む

FIPSポリシー。

システム全体のサブポリシー FIPS:OSPP には、Common Criteria (CC) 認定に必要な暗号化アルゴリズムに関する追加の制限が含まれています。そのため、このサブポリシーを設定すると、システムの相互運用性が低下します。たとえば、3072 ビットより短い RSA 鍵と DH 鍵、追加の SSH アルゴリズム、および複数の TLS グループを使用できません。また、FIPS:OSPP を設定すると、Red Hat コンテンツ配信ネットワーク (CDN) 構造への接続が防止されます。さらに、FIPS:OSPP を使用する IdM デプロイメントには Active Directory (AD) を統合できません。FIPS:OSPP を使用する RHEL ホストと AD ドメイン間の通信が機能しないか、一部の AD アカウントが認証できない可能性があります。

FIPS:OSPP 暗号化サブポリシーを設定すると、システムが CC 非準拠になる ことに注意してください。RHEL システムを CC 標準に準拠させる唯一の正しい方法は、cc-config パッケージで提供されているガイダンスに従うことです。認定された RHEL バージョン、検証レポート、および National Information Assurance Partnership (NIAP) の Web サイトでホストされる CC ガイドへのリンクのリストは、Red Hat カスタマーポータルページの Product compliance の Common Criteria セクションを参照してください。

前提条件

- RHEL 9 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

-

root特権、またはsudoを使用して管理コマンドを入力する権限がある。

手順

RHEL 9 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

Overview ページの Configuration カードで、Crypto policy の横にある現在のポリシー値をクリックします。

Change crypto policy ダイアログウィンドウで、システムで使用を開始するポリシーをクリックします。

- ボタンをクリックします。

検証

再起動後、Web コンソールに再度ログインし、暗号化ポリシー の値が選択したものと一致していることを確認します。

あるいは、

update-crypto-policies --showコマンドを入力して、現在のシステム全体の暗号化ポリシーをターミナルに表示することもできます。

3.6. システム全体の暗号化ポリシーからアプリケーションを除外する

アプリケーションで使用される暗号化関連の設定をカスタマイズする必要がある場合は、サポートされる暗号スイートとプロトコルをアプリケーションで直接設定することが推奨されます。

/etc/crypto-policies/back-ends ディレクトリーからアプリケーション関連のシンボリックリンクを削除することもできます。カスタマイズした暗号化設定に置き換えることもできます。この設定により、除外されたバックエンドを使用するアプリケーションに対するシステム全体の暗号化ポリシーが使用できなくなります。この修正は、Red Hat ではサポートされていません。

3.6.1. システム全体の暗号化ポリシーをオプトアウトする例

wget

wget ネットワークダウンローダーで使用される暗号化設定をカスタマイズするには、--secure-protocol オプションおよび --ciphers オプションを使用します。以下に例を示します。

wget --secure-protocol=TLSv1_1 --ciphers="SECURE128" https://example.com

$ wget --secure-protocol=TLSv1_1 --ciphers="SECURE128" https://example.com

詳細は、wget(1) man ページの HTTPS (SSL/TLS) Options のセクションを参照してください。

curl

curl ツールで使用する暗号を指定するには、--ciphers オプションを使用して、その値に、コロンで区切った暗号化のリストを指定します。以下に例を示します。

curl https://example.com --ciphers '@SECLEVEL=0:DES-CBC3-SHA:RSA-DES-CBC3-SHA'

$ curl https://example.com --ciphers '@SECLEVEL=0:DES-CBC3-SHA:RSA-DES-CBC3-SHA'

詳細は、curl(1) の man ページを参照してください。

Firefox

Web ブラウザーの Firefox でシステム全体の暗号化ポリシーをオプトアウトできない場合でも、Firefox の設定エディターで、対応している暗号と TLS バージョンをさらに詳細に制限できます。アドレスバーに about:config と入力し、必要に応じて security.tls.version.min の値を変更します。たとえば、security.tls.version.min を 1 に設定すると、最低でも TLS 1.0 が必要になり、security.tls.version.min 2 が TLS 1.1 になります。

OpenSSH

OpenSSH サーバーのシステム全体の暗号化ポリシーをオプトアウトするには、/etc/ssh/sshd_config.d/ ディレクトリーにあるドロップイン設定ファイルに暗号化ポリシーを指定します。このとき、辞書式順序で 50-redhat.conf ファイルよりも前に来るように、50 未満の 2 桁の数字接頭辞と、.conf という接尾辞を付けます (例: 49-crypto-policy-override.conf)。

詳細は、sshd_config(5) の man ページを参照してください。

OpenSSH クライアントのシステム全体の暗号化ポリシーをオプトアウトするには、次のいずれかのタスクを実行します。

-

指定のユーザーの場合は、

~/.ssh/configファイルのユーザー固有の設定でグローバルのssh_configを上書きします。 -

システム全体の場合は、

/etc/ssh/ssh_config.d/ディレクトリーにあるドロップイン設定ファイルに暗号化ポリシーを指定します。このとき、辞書式順序で50-redhat.confファイルよりも前に来るように、50 未満の 2 桁の接頭辞と、.confという接尾辞を付けます (例:49-crypto-policy-override.conf)。

詳細は、ssh_config(5) の man ページを参照してください。

Libreswan

詳細は、Securing networks の Configuring IPsec connections that opt out of the system-wide crypto policies を参照してください。

3.7. サブポリシーを使用したシステム全体の暗号化ポリシーのカスタマイズ

この手順を使用して、有効な暗号化アルゴリズムまたはプロトコルのセットを調整します。

既存のシステム全体の暗号化ポリシーの上にカスタムサブポリシーを適用するか、そのようなポリシーを最初から定義することができます。

スコープが設定されたポリシーの概念により、バックエンドごとに異なるアルゴリズムセットを有効にできます。各設定ディレクティブは、特定のプロトコル、ライブラリー、またはサービスに限定できます。

また、ディレクティブでは、ワイルドカードを使用して複数の値を指定する場合にアスタリスクを使用できます。

/etc/crypto-policies/state/CURRENT.pol ファイルには、ワイルドカードデプロイメント後に現在適用されているシステム全体の暗号化ポリシーのすべての設定がリスト表示されます。暗号化ポリシーをより厳密にするには、/usr/share/crypto-policies/policies/FUTURE.pol ファイルにリストされている値を使用することを検討してください。

サブポリシーの例は、/usr/share/crypto-policies/policies/modules/ ディレクトリーにあります。このディレクトリーのサブポリシーファイルには、コメントアウトされた行に説明が含まれています。

手順

/etc/crypto-policies/policies/modules/ディレクトリーをチェックアウトします。cd /etc/crypto-policies/policies/modules/

# cd /etc/crypto-policies/policies/modules/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 調整用のサブポリシーを作成します。次に例を示します。

touch MYCRYPTO-1.pmod touch SCOPES-AND-WILDCARDS.pmod

# touch MYCRYPTO-1.pmod # touch SCOPES-AND-WILDCARDS.pmodCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要ポリシーモジュールのファイル名には大文字を使用します。

任意のテキストエディターでポリシーモジュールを開き、システム全体の暗号化ポリシーを変更するオプションを挿入します。次に例を示します。

vi MYCRYPTO-1.pmod

# vi MYCRYPTO-1.pmodCopy to Clipboard Copied! Toggle word wrap Toggle overflow min_rsa_size = 3072 hash = SHA2-384 SHA2-512 SHA3-384 SHA3-512

min_rsa_size = 3072 hash = SHA2-384 SHA2-512 SHA3-384 SHA3-512Copy to Clipboard Copied! Toggle word wrap Toggle overflow vi SCOPES-AND-WILDCARDS.pmod

# vi SCOPES-AND-WILDCARDS.pmodCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更をモジュールファイルに保存します。

ポリシーの調整を、システム全体の暗号化ポリシーレベル

DEFAULTに適用します。update-crypto-policies --set DEFAULT:MYCRYPTO-1:SCOPES-AND-WILDCARDS

# update-crypto-policies --set DEFAULT:MYCRYPTO-1:SCOPES-AND-WILDCARDSCopy to Clipboard Copied! Toggle word wrap Toggle overflow 暗号化設定を実行中のサービスやアプリケーションで有効にするには、システムを再起動します。

reboot

# rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

/etc/crypto-policies/state/CURRENT.polファイルに変更が含まれていることを確認します。以下に例を示します。cat /etc/crypto-policies/state/CURRENT.pol | grep rsa_size min_rsa_size = 3072

$ cat /etc/crypto-policies/state/CURRENT.pol | grep rsa_size min_rsa_size = 3072Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.8. システム全体のカスタム暗号化ポリシーの作成および設定

完全なポリシーファイルを作成して使用することで、システム全体の暗号化ポリシーを特定の状況向けにカスタマイズできます。

手順

カスタマイズのポリシーファイルを作成します。

cd /etc/crypto-policies/policies/ touch MYPOLICY.pol

# cd /etc/crypto-policies/policies/ # touch MYPOLICY.polCopy to Clipboard Copied! Toggle word wrap Toggle overflow または、定義されている 4 つのポリシーレベルのいずれかをコピーします。

cp /usr/share/crypto-policies/policies/DEFAULT.pol /etc/crypto-policies/policies/MYPOLICY.pol

# cp /usr/share/crypto-policies/policies/DEFAULT.pol /etc/crypto-policies/policies/MYPOLICY.polCopy to Clipboard Copied! Toggle word wrap Toggle overflow 必要に応じて、テキストエディターでファイルを編集します。以下のようにしてカスタム暗号化ポリシーを使用します。

vi /etc/crypto-policies/policies/MYPOLICY.pol

# vi /etc/crypto-policies/policies/MYPOLICY.polCopy to Clipboard Copied! Toggle word wrap Toggle overflow システム全体の暗号化ポリシーをカスタムレベルに切り替えます。

update-crypto-policies --set MYPOLICY

# update-crypto-policies --set MYPOLICYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 暗号化設定を実行中のサービスやアプリケーションで有効にするには、システムを再起動します。

reboot

# rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.9. crypto_policies RHEL システムロールを使用した FUTURE 暗号化ポリシーによるセキュリティーの強化

crypto_policies RHEL システムロールを使用して、管理対象ノードで FUTURE ポリシーを設定できます。このポリシーは、たとえば次のことを実現するのに役立ちます。

- 将来の新たな脅威への対応: 計算能力の向上を予測します。

- セキュリティーの強化: 強力な暗号化標準により、より長い鍵長とよりセキュアなアルゴリズムを必須にします。

- 高度なセキュリティー標準への準拠: 医療、通信、金融などの分野ではデータの機密性が高く、強力な暗号化を利用できることが重要です。

通常、FUTURE は、機密性の高いデータを扱う環境、将来の規制に備える環境、長期的なセキュリティーストラテジーを採用する環境に適しています。

レガシーのシステムやソフトウェアでは、FUTURE ポリシーによって強制される、より最新しく厳格なアルゴリズムやプロトコルをサポートする必要はありません。たとえば、古いシステムでは TLS 1.3 以上の鍵サイズがサポートされていない可能性があります。これにより互換性の問題が発生する可能性があります。

また、強力なアルゴリズムを使用すると、通常、計算負荷が増加し、システムのパフォーマンスに悪影響が及ぶ可能性があります。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow サンプル Playbook で指定されている設定は次のとおりです。

crypto_policies_policy: FUTURE-

管理対象ノードで必要な暗号化ポリシー (

FUTURE) を設定します。これは、基本ポリシー、またはいくつかのサブポリシーを含む基本ポリシーのどちらかです。指定した基本ポリシーとサブポリシーが、管理対象ノードで使用可能である必要があります。デフォルト値はnullです。つまり、設定は変更されず、crypto_policiesRHEL システムロールは Ansible fact のみを収集します。 crypto_policies_reboot_ok: true-

すべてのサービスとアプリケーションが新しい設定ファイルを読み取るように、暗号化ポリシーの変更後にシステムを再起動します。デフォルト値は

falseです。

Playbook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.crypto_policies/README.mdファイルを参照してください。Playbook の構文を検証します。

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

システム全体のサブポリシー FIPS:OSPP には、Common Criteria (CC) 認定に必要な暗号化アルゴリズムに関する追加の制限が含まれています。そのため、このサブポリシーを設定すると、システムの相互運用性が低下します。たとえば、3072 ビットより短い RSA 鍵と DH 鍵、追加の SSH アルゴリズム、および複数の TLS グループを使用できません。また、FIPS:OSPP を設定すると、Red Hat コンテンツ配信ネットワーク (CDN) 構造への接続が防止されます。さらに、FIPS:OSPP を使用する IdM デプロイメントには Active Directory (AD) を統合できません。FIPS:OSPP を使用する RHEL ホストと AD ドメイン間の通信が機能しないか、一部の AD アカウントが認証できない可能性があります。

FIPS:OSPP 暗号化サブポリシーを設定すると、システムが CC 非準拠になる ことに注意してください。RHEL システムを CC 標準に準拠させる唯一の正しい方法は、cc-config パッケージで提供されているガイダンスに従うことです。認定された RHEL バージョン、検証レポート、および National Information Assurance Partnership (NIAP) の Web サイトでホストされる CC ガイドへのリンクのリストは、Red Hat カスタマーポータルページの Product compliance の Common Criteria セクションを参照してください。

検証

コントロールノードで、たとえば

verify_playbook.ymlという名前の別の Playbook を作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow サンプル Playbook で指定されている設定は次のとおりです。

crypto_policies_active-

crypto_policies_policy変数で受け入れられる形式の現在アクティブなポリシー名が含まれているエクスポートされた Ansible fact。

Playbook の構文を検証します。

ansible-playbook --syntax-check ~/verify_playbook.yml

$ ansible-playbook --syntax-check ~/verify_playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Playbook を実行します。

ansible-playbook ~/verify_playbook.yml TASK [debug] ************************** ok: [host] => { "crypto_policies_active": "FUTURE" }$ ansible-playbook ~/verify_playbook.yml TASK [debug] ************************** ok: [host] => { "crypto_policies_active": "FUTURE" }Copy to Clipboard Copied! Toggle word wrap Toggle overflow crypto_policies_active変数は、管理対象ノード上のアクティブなポリシーを示します。

第4章 PKCS #11 で暗号化ハードウェアを使用するようにアプリケーションを設定

スマートカードや、エンドユーザー認証用の暗号化トークン、サーバーアプリケーション用のハードウェアセキュリティーモジュール (HSM) など、専用の暗号化デバイスで秘密情報の一部を分離することで、セキュリティー層が追加されます。RHEL では、PKCS #11 API を使用した暗号化ハードウェアへの対応がアプリケーション間で統一され、暗号ハードウェアでの秘密の分離が複雑なタスクではなくなりました。

4.1. PKCS #11 による暗号化ハードウェアへの対応

Public-Key Cryptography Standard (PKCS) #11 は、暗号化情報を保持し、暗号化機能を実行する暗号化デバイスへのアプリケーションプログラミングインターフェイス (API) を定義します。

PKCS #11 では、各ハードウェアまたはソフトウェアデバイスを統一された方法でアプリケーションに提示するオブジェクトである 暗号化トークン が導入されています。したがって、アプリケーションは、通常はユーザーによって使用されるスマートカードなどのデバイスや、通常はコンピューターによって使用されるハードウェアセキュリティーモジュールを PKCS #11 暗号化トークンとして認識します。

PKCS #11 トークンには、証明書、データオブジェクト、公開鍵、秘密鍵、または秘密鍵を含むさまざまなオブジェクトタイプを保存できます。これらのオブジェクトは、PKCS #11 Uniform Resource Identifier (URI) スキームを通じて一意に識別できます。

PKCS #11 の URI は、オブジェクト属性に従って、PKCS #11 モジュールで特定のオブジェクトを識別する標準的な方法です。これにより、URI の形式で、すべてのライブラリーとアプリケーションを同じ設定文字列で設定できます。

RHEL では、デフォルトでスマートカード用に OpenSC PKCS #11 ドライバーが提供されています。ただし、ハードウェアトークンと HSM には、システムにカウンターパートを持たない独自の PKCS #11 モジュールがあります。この PKCS #11 モジュールは p11-kit ツールで登録できます。これは、システムの登録済みスマートカードドライバーにおけるラッパーとして機能します。

システムで独自の PKCS #11 モジュールを有効にするには、新しいテキストファイルを /etc/pkcs11/modules/ ディレクトリーに追加します。

/etc/pkcs11/modules/ ディレクトリーに新しいテキストファイルを作成すると、独自の PKCS #11 モジュールをシステムに追加できます。たとえば、p11-kit の OpenSC 設定ファイルは、以下のようになります。

cat /usr/share/p11-kit/modules/opensc.module module: opensc-pkcs11.so

$ cat /usr/share/p11-kit/modules/opensc.module

module: opensc-pkcs11.so4.2. スマートカードに保存した SSH 鍵による認証

スマートカードに ECDSA 鍵と RSA 鍵を作成して保存し、そのスマートカードを使用して OpenSSH クライアントで認証することができます。スマートカード認証は、デフォルトのパスワード認証に代わるものです。

前提条件

-

クライアントで、

openscパッケージをインストールして、pcscdサービスを実行している。

手順

PKCS #11 の URI を含む OpenSC PKCS #11 モジュールが提供する鍵のリストを表示し、その出力を

keys.pubファイルに保存します。ssh-keygen -D pkcs11: > keys.pub

$ ssh-keygen -D pkcs11: > keys.pubCopy to Clipboard Copied! Toggle word wrap Toggle overflow 公開鍵をリモートサーバーに転送します。

ssh-copy-idコマンドを使用し、前の手順で作成したkeys.pubファイルを指定します。ssh-copy-id -f -i keys.pub <username@ssh-server-example.com>

$ ssh-copy-id -f -i keys.pub <username@ssh-server-example.com>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ECDSA 鍵を使用して <ssh-server-example.com> に接続します。鍵を一意に参照する URI のサブセットのみを使用することもできます。次に例を示します。

ssh -i "pkcs11:id=%01?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so" <ssh-server-example.com> Enter PIN for 'SSH key': [ssh-server-example.com] $

$ ssh -i "pkcs11:id=%01?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so" <ssh-server-example.com> Enter PIN for 'SSH key': [ssh-server-example.com] $Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenSSH は

p11-kit-proxyラッパーを使用し、OpenSC PKCS #11 モジュールがp11-kitツールに登録されているため、前のコマンドを簡略化できます。ssh -i "pkcs11:id=%01" <ssh-server-example.com> Enter PIN for 'SSH key': [ssh-server-example.com] $

$ ssh -i "pkcs11:id=%01" <ssh-server-example.com> Enter PIN for 'SSH key': [ssh-server-example.com] $Copy to Clipboard Copied! Toggle word wrap Toggle overflow PKCS #11 の URI の

id=の部分を飛ばすと、OpenSSH が、プロキシーモジュールで利用可能な鍵をすべて読み込みます。これにより、必要な入力の量を減らすことができます。ssh -i pkcs11: <ssh-server-example.com> Enter PIN for 'SSH key': [ssh-server-example.com] $

$ ssh -i pkcs11: <ssh-server-example.com> Enter PIN for 'SSH key': [ssh-server-example.com] $Copy to Clipboard Copied! Toggle word wrap Toggle overflow オプション:

~/.ssh/configファイルで同じ URI 文字列を使用して、設定を永続的にすることができます。cat ~/.ssh/config IdentityFile "pkcs11:id=%01?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so" $ ssh <ssh-server-example.com> Enter PIN for 'SSH key': [ssh-server-example.com] $

$ cat ~/.ssh/config IdentityFile "pkcs11:id=%01?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so" $ ssh <ssh-server-example.com> Enter PIN for 'SSH key': [ssh-server-example.com] $Copy to Clipboard Copied! Toggle word wrap Toggle overflow sshクライアントユーティリティーが、この URI とスマートカードの鍵を自動的に使用するようになります。

4.3. スマートカード上の証明書を使用して認証するアプリケーションの設定

アプリケーションでスマートカードを使用して認証することにより、セキュリティーが強化され、自動化が簡素化される場合があります。次の方法を使用して、Public Key Cryptography Standard (PKCS) #11 URI をアプリケーションに統合できます。

-

FirefoxWeb ブラウザーは、p11-kit-proxyPKCS #11 モジュールを自動的にロードします。つまり、システムで対応しているすべてのスマートカードが自動的に検出されます。TLS クライアント認証を使用する場合、追加のセットアップは必要ありません。サーバーが要求したときにスマートカードの鍵と証明書が自動的に使用されます。 -

アプリケーションが

GnuTLSまたはNSSライブラリーを使用している場合、PKCS #11 URI はすでにサポートされています。また、OpenSSLライブラリーに依存するアプリケーションは、openssl-pkcs11パッケージによって提供されるpkcs11エンジンを通じて、スマートカードを含む暗号化ハードウェアモジュールにアクセスできます。 -

スマートカード上の秘密鍵を操作する必要があり、

NSS、GnuTLS、OpenSSLを使用しないアプリケーションは、特定の PKCS #11 モジュールの PKCS #11 API を使用するのではなく、p11-kitAPI を直接使用して、スマートカードを含む暗号化ハードウェアモジュールを操作できます。 wgetネットワークダウンローダーを使用すると、ローカルに保存された秘密鍵と証明書へのパスの代わりに PKCS #11 URI を指定できます。これにより、安全に保管された秘密鍵と証明書を必要とするタスクのスクリプトの作成が簡素化される可能性があります。以下に例を示します。wget --private-key 'pkcs11:token=softhsm;id=%01;type=private?pin-value=111111' --certificate 'pkcs11:token=softhsm;id=%01;type=cert' https://example.com/

$ wget --private-key 'pkcs11:token=softhsm;id=%01;type=private?pin-value=111111' --certificate 'pkcs11:token=softhsm;id=%01;type=cert' https://example.com/Copy to Clipboard Copied! Toggle word wrap Toggle overflow また、

curlツールを使用する場合は、PKCS #11 URI を指定することもできます。curl --key 'pkcs11:token=softhsm;id=%01;type=private?pin-value=111111' --cert 'pkcs11:token=softhsm;id=%01;type=cert' https://example.com/

$ curl --key 'pkcs11:token=softhsm;id=%01;type=private?pin-value=111111' --cert 'pkcs11:token=softhsm;id=%01;type=cert' https://example.com/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記PIN は、スマートカードに保存されている鍵へのアクセスを制御するセキュリティー対策であり、設定ファイルにはプレーンテキスト形式の PIN が含まれているため、攻撃者が PIN を読み取れないように追加の保護を検討してください。たとえば、

pin-source属性を使用して、ファイルから PIN を読み取るためのfile:URI を指定できます。詳細は、RFC 7512: PKCS #11 URI Scheme Query Attribute Semantics を参照してください。コマンドパスをpin-source属性の値として使用することには対応していないことに注意してください。

4.4. Apache で秘密鍵を保護する HSM の使用

Apache HTTP サーバーは、ハードウェアセキュリティーモジュール (HSM) に保存されている秘密鍵と連携できます。これにより、鍵の漏えいや中間者攻撃を防ぐことができます。通常、これを行うには、ビジーなサーバーに高パフォーマンスの HSM が必要になります。

HTTPS プロトコルの形式でセキュアな通信を行うために、Apache HTTP サーバー (httpd) は OpenSSL ライブラリーを使用します。OpenSSL は、PKCS #11 にネイティブに対応しません。HSM を使用するには、エンジンインターフェイスを介して PKCS #11 モジュールへのアクセスを提供する openssl-pkcs11 パッケージをインストールする必要があります。通常のファイル名ではなく PKCS #11 の URI を使用すると、/etc/httpd/conf.d/ssl.conf 設定ファイルでサーバーの鍵と証明書を指定できます。以下に例を示します。

SSLCertificateFile "pkcs11:id=%01;token=softhsm;type=cert" SSLCertificateKeyFile "pkcs11:id=%01;token=softhsm;type=private?pin-value=111111"

SSLCertificateFile "pkcs11:id=%01;token=softhsm;type=cert"

SSLCertificateKeyFile "pkcs11:id=%01;token=softhsm;type=private?pin-value=111111"

httpd-manual パッケージをインストールして、TLS 設定を含む Apache HTTP サーバーの完全ドキュメントを取得します。/etc/httpd/conf.d/ssl.conf 設定ファイルで利用可能なディレクティブの詳細は、/usr/share/httpd/manual/mod/mod_ssl.html を参照してください。

4.5. Nginx で秘密鍵を保護する HSM の使用

Nginx HTTP サーバーは、ハードウェアセキュリティーモジュール (HSM) に保存されている秘密鍵と連携できます。これにより、鍵の漏えいや中間者攻撃を防ぐことができます。通常、これを行うには、ビジーなサーバーに高パフォーマンスの HSM が必要になります。

Nginx は暗号化操作に OpenSSL を使用するため、PKCS #11 への対応は openssl-pkcs11 エンジンを介して行う必要があります。Nginx は現在、HSM からの秘密鍵の読み込みのみに対応します。また、証明書は通常のファイルとして個別に提供する必要があります。/etc/nginx/nginx.conf 設定ファイルの server セクションで ssl_certificate オプションおよび ssl_certificate_key オプションを変更します。

ssl_certificate /path/to/cert.pem ssl_certificate_key "engine:pkcs11:pkcs11:token=softhsm;id=%01;type=private?pin-value=111111";

ssl_certificate /path/to/cert.pem

ssl_certificate_key "engine:pkcs11:pkcs11:token=softhsm;id=%01;type=private?pin-value=111111";

Nginx 設定ファイルの PKCS #11 URI に接頭辞 engine:pkcs11: が必要なことに注意してください。これは、他の pkcs11 接頭辞がエンジン名を参照するためです。

第5章 polkit を使用したスマートカードへのアクセスの制御

PIN、PIN パッド、バイオメトリックなどのスマートカードに組み込まれたメカニズムでは防ぐことができない脅威に対処するため、およびより詳細な制御のために、RHEL は polkit フレームワークを使用してスマートカードへのアクセス制御を制御します。

システム管理者は、非特権ユーザーや非ローカルユーザー、サービスに対するスマートカードアクセスなど、特定のシナリオに合わせて polkit を設定できます。

5.1. polkit を介したスマートカードアクセス制御

PC/SC (Personal Computer/Smart Card) プロトコルは、スマートカードとそのリーダーをコンピューティングシステムに統合するための標準を指定します。RHEL では、pcsc-lite パッケージが、PC/SC の API を使用するスマートカードにアクセスするミドルウェアを提供します。このパッケージの一部である pcscd (PC/SC スマートカード) デーモンにより、システムが PC/SC プロトコルを使用してスマートカードにアクセスできるようになります。

PIN、PIN パッド、バイオメトリックなどのスマートカードに組み込まれたアクセス制御メカニズムは、考えられるすべての脅威をカバーするものではないため、RHEL は、より強力なアクセス制御に polkit フレームワークを使用します。polkit 認可マネージャーは、特権操作へのアクセスを許可できます。ディスクへのアクセスを許可することに加えて、polkit を使用して、スマートカードのセキュリティーを保護するポリシーを指定することもできます。たとえば、スマートカードで操作を実行できるユーザーを定義できます。

pcsc-lite パッケージをインストールし、pcscd デーモンを起動すると、システムは、/usr/share/polkit-1/actions/ ディレクトリーで定義されているポリシーを強制します。システム全体のデフォルトのポリシーは、/usr/share/polkit-1/actions/org.debian.pcsc-lite.policy ファイルにあります。Polkit ポリシーファイルは XML 形式を使用します。構文は、システム上の polkit(8) man ページで説明されています。

polkitd は、/etc/polkit-1/rules.d/ ディレクトリーおよび /usr/share/polkit-1/rules.d/ ディレクトリーで、これらのディレクトリーに保存されているルールファイルの変更を監視します。ファイルには、JavaScript 形式の認可ルールが含まれています。システム管理者は、両方のディレクトリーにカスタムルールファイルを追加し、polkitd がファイル名に基づいてアルファベット順に読み込むことができます。2 つのファイルが同じ名前である場合は、最初に /etc/polkit-1/rules.d/ 内のファイルが読み込まれます。

System Security Services Daemon (SSSD) が root として実行されていないときにスマートカードのサポートを有効にする必要がある場合は、sssd-polkit-rules パッケージをインストールする必要があります。このパッケージは、SSSD と polkit の統合を提供します。

5.3. PC/SC への polkit 認可の詳細情報の表示

デフォルト設定では、polkit 認可フレームワークは、限られた情報のみをジャーナルログに送信します。新しいルールを追加することで、PC/SC プロトコル関連の polkit ログエントリーを拡張できます。

前提条件

-

システムに

pcsc-liteパッケージをインストールしている。 -

pcscdデーモンが実行中である。

手順

/etc/polkit-1/rules.d/ディレクトリーに新規ファイルを作成します。touch /etc/polkit-1/rules.d/00-test.rules

# touch /etc/polkit-1/rules.d/00-test.rulesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 選択したエディターでファイルを編集します。以下に例を示します。

vi /etc/polkit-1/rules.d/00-test.rules

# vi /etc/polkit-1/rules.d/00-test.rulesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の行を挿入します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

pcscdサービスおよびpolkitサービスを再起動します。systemctl restart pcscd.service pcscd.socket polkit.service

# systemctl restart pcscd.service pcscd.socket polkit.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

-

pcscdの認可リクエストを作成します。たとえば、Firefox の Web ブラウザーを開くか、openscが提供するpkcs11-tool -Lを使用します。 拡張ログエントリーを表示します。以下に例を示します。

journalctl -u polkit --since "1 hour ago" polkitd[1224]: <no filename>:4: action=[Action id='org.debian.pcsc-lite.access_pcsc'] polkitd[1224]: <no filename>:5: subject=[Subject pid=2020481 user=user' groups=user,wheel,mock,wireshark seat=null session=null local=true active=true]

# journalctl -u polkit --since "1 hour ago" polkitd[1224]: <no filename>:4: action=[Action id='org.debian.pcsc-lite.access_pcsc'] polkitd[1224]: <no filename>:5: subject=[Subject pid=2020481 user=user' groups=user,wheel,mock,wireshark seat=null session=null local=true active=true]Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第6章 設定コンプライアンスおよび脆弱性スキャンの開始

コンプライアンス監査は、指定したオブジェクトが、コンプライアンスポリシーに指定されているすべてのルールに従っているかどうかを判断するプロセスです。コンプライアンスポリシーは、コンピューティング環境で使用される必要な設定を指定するセキュリティー専門家が定義します。これは多くの場合は、チェックリストの形式を取ります。

コンプライアンスポリシーは組織により大幅に異なることがあり、同一組織内でもシステムが異なるとポリシーが異なる可能性があります。ポリシーは、各システムの目的や、組織におけるシステム重要性により異なります。カスタマイズしたソフトウェア設定や導入の特徴によっても、カスタマイズしたポリシーのチェックリストが必要になってきます。

6.1. RHEL における設定コンプライアンスツール

次の設定コンプライアンスツールを使用すると、Red Hat Enterprise Linux で完全に自動化されたコンプライアンス監査を実行できます。このツールは SCAP (Security Content Automation Protocol) 規格に基づいており、コンプライアンスポリシーの自動化に合わせるように設計されています。

- SCAP Workbench

-

scap-workbenchグラフィカルユーティリティーは、単一のローカルシステムまたはリモートシステム上で設定および脆弱性スキャンを実行するように設計されています。これらのスキャンと評価に基づくセキュリティーレポートの生成にも使用できます。 - OpenSCAP

OpenSCAPライブラリーは、付随するoscapコマンドラインユーティリティーとともに、ローカルシステムで設定スキャンと脆弱性スキャンを実行するように設計されています。これにより、設定コンプライアンスのコンテンツを検証し、スキャンおよび評価に基づいてレポートおよびガイドを生成します。重要OpenSCAP の使用中にメモリー消費の問題が発生する可能性があります。これにより、プログラムが途中で停止し、結果ファイルが生成されない可能性があります。詳細は、ナレッジベース記事 OpenSCAP のメモリー消費の問題 を参照してください。

- SCAP Security Guide (SSG)

-

scap-security-guideパッケージは、Linux システム用のセキュリティーポリシーのコレクションを提供します。このガイダンスは、セキュリティー強化に関する実践的なアドバイスのカタログで構成されています (該当する場合は、法規制要件へのリンクが含まれます)。このプロジェクトは、一般的なポリシー要件と特定の実装ガイドラインとの間にあるギャップを埋めることを目的としています。 - Script Check Engine (SCE)

-

SCAP プロトコルの拡張機能である SCE を使用すると、管理者は Bash、Python、Ruby などのスクリプト言語を使用してセキュリティーコンテンツを作成できます。SCE 拡張機能は、

openscap-engine-sceパッケージで提供されます。SCE 自体は SCAP 標準規格の一部ではありません。

複数のリモートシステムで自動コンプライアンス監査を実行する必要がある場合は、Red Hat Satellite 用の OpenSCAP ソリューションを利用できます。

6.2. 脆弱性スキャン

6.2.1. Red Hat Security Advisories OVAL フィード

Red Hat Enterprise Linux のセキュリティー監査機能は、標準規格セキュリティー設定共通化手順 (Security Content Automation Protocol (SCAP)) を基にしています。SCAP は、自動化された設定、脆弱性およびパッチの確認、技術的な制御コンプライアンスアクティビティー、およびセキュリティーの測定に対応している多目的な仕様のフレームワークです。

SCAP 仕様は、スキャナーまたはポリシーエディターの実装が義務付けられていなくても、セキュリティーコンテンツの形式がよく知られて標準化されているエコシステムを作成します。これにより、組織は、採用しているセキュリティーベンダーの数に関係なく、セキュリティーポリシー (SCAP コンテンツ) を構築するのは一度で済みます。

セキュリティー検査言語 OVAL (Open Vulnerability Assessment Language) は、SCAP に不可欠で最も古いコンポーネントです。その他のツールやカスタマイズされたスクリプトとは異なり、OVAL は、宣言型でリソースが必要な状態を記述します。OVAL コードは、スキャナーと呼ばれる OVAL インタープリターツールを使用して直接実行されることは決してありません。OVAL が宣言型であるため、評価されるシステムの状態が偶然修正されることはありません。

他のすべての SCAP コンポーネントと同様に、OVAL は XML に基づいています。SCAP 標準規格は、いくつかのドキュメント形式を定義します。この形式にはそれぞれ異なる種類の情報が記載され、異なる目的に使用されます。

Red Hat 製品セキュリティー を使用すると、Red Hat 製品をお使いのお客様に影響を及ぼすセキュリティー問題をすべて追跡して調査します。Red Hat カスタマーポータルで簡潔なパッチやセキュリティーアドバイザリーを適時提供します。Red Hat は OVAL パッチ定義を作成してサポートし、マシンが判読可能なセキュリティーアドバイザリーを提供します。

プラットフォーム、バージョン、およびその他の要因が異なるため、Red Hat 製品セキュリティーによる脆弱性の重大度定性評価は、サードパーティーが提供する Common Vulnerability Scoring System (CVSS) のベースライン評価と完全に一致しているわけではありません。したがって、サードパーティーが提供する定義ではなく、RHSA OVAL 定義を使用することが推奨されます。

各 RHSA OVAL 定義 は完全なパッケージとして利用でき、新しいセキュリティーアドバイザリーが Red Hat カスタマーポータルで利用可能になってから 1 時間以内に更新されます。

各 OVAL パッチ定義は、Red Hat セキュリティーアドバイザリー (RHSA) と 1 対 1 にマッピングしています。RHSA には複数の脆弱性に対する修正が含まれるため、各脆弱性は、共通脆弱性識別子 (Common Vulnerabilities and Exposures (CVE)) 名ごとに表示され、公開バグデータベースの該当箇所へのリンクが示されます。

RHSA OVAL 定義は、システムにインストールされている RPM パッケージで脆弱なバージョンを確認するように設計されています。この定義は拡張でき、パッケージが脆弱な設定で使用されているかどうかを見つけるなど、さらに確認できるようにすることができます。この定義は、Red Hat が提供するソフトウェアおよび更新に対応するように設計されています。サードパーティーソフトウェアのパッチ状態を検出するには、追加の定義が必要です。

Red Hat Insights for Red Hat Enterprise Linux コンプライアンスサービス は、IT セキュリティーおよびコンプライアンス管理者が Red Hat Enterprise Linux システムのセキュリティーポリシーのコンプライアンスを評価、監視、およびレポートするのに役立ちます。また、コンプライアンスサービス UI 内で完全に SCAP セキュリティーポリシーを作成および管理することもできます。

6.2.2. システムの脆弱性のスキャン

oscap コマンドラインユーティリティーを使用すると、ローカルシステムのスキャン、設定コンプライアンスコンテンツの確認、ならびにスキャンおよび評価を基にしたレポートとガイドの生成が可能です。このユーティリティーは、OpenSCAP ライブラリーのフロントエンドとしてサービスを提供し、その機能を処理する SCAP コンテンツのタイプに基づいてモジュール (サブコマンド) にグループ化します。

前提条件

-

openscap-scannerおよびbzip2パッケージがインストールされます。

手順

システムに最新 RHSA OVAL 定義をダウンロードします。

wget -O - https://www.redhat.com/security/data/oval/v2/RHEL9/rhel-9.oval.xml.bz2 | bzip2 --decompress > rhel-9.oval.xml

# wget -O - https://www.redhat.com/security/data/oval/v2/RHEL9/rhel-9.oval.xml.bz2 | bzip2 --decompress > rhel-9.oval.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow システムの脆弱性をスキャンし、vulnerability.html ファイルに結果を保存します。

oscap oval eval --report vulnerability.html rhel-9.oval.xml

# oscap oval eval --report vulnerability.html rhel-9.oval.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

結果をブラウザーで確認します。以下に例を示します。

firefox vulnerability.html &

$ firefox vulnerability.html &Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.3. リモートシステムの脆弱性のスキャン

SSH プロトコル経由で oscap-ssh ツールを使用して、OpenSCAP スキャナーでリモートシステムの脆弱性をチェックできます。

前提条件

-

openscap-utilsおよびbzip2パッケージは、スキャンに使用するシステムにインストールされます。 -

リモートシステムに

openscap-scannerパッケージがインストールされている。 - リモートシステムで SSH サーバーが実行している。

手順

システムに最新 RHSA OVAL 定義をダウンロードします。

wget -O - https://www.redhat.com/security/data/oval/v2/RHEL9/rhel-9.oval.xml.bz2 | bzip2 --decompress > rhel-9.oval.xml

# wget -O - https://www.redhat.com/security/data/oval/v2/RHEL9/rhel-9.oval.xml.bz2 | bzip2 --decompress > rhel-9.oval.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow リモートシステムの脆弱性をスキャンし、結果をファイルに保存します。

oscap-ssh <username>@<hostname> <port> oval eval --report <scan-report.html> rhel-9.oval.xml

# oscap-ssh <username>@<hostname> <port> oval eval --report <scan-report.html> rhel-9.oval.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のように置き換えます。

-

<username>@<hostname>は、リモートシステムのユーザー名とホスト名に置き換えます。 -

<port>は、リモートシステムにアクセスできるポート番号 (例:22) です。 -

<scan-report.html>は、oscapがスキャン結果を保存するファイル名です。

-

6.3. 設定コンプライアンススキャン

6.3.1. RHEL の設定コンプライアンス

設定コンプライアンススキャンを使用して、特定の組織で定義されているベースラインに準拠できます。たとえば、米国政府と協力している場合は、システムを Operating System Protection Profile (OSPP) に準拠させ、支払い処理業者の場合は、システムを Payment Card Industry Data Security Standard (PCI-DSS) に準拠させなければならない場合があります。設定コンプライアンススキャンを実行して、システムセキュリティーを強化することもできます。

Red Hat は、対象コンポーネント向けの Red Hat のベストプラクティスに従っているため、SCAP Security Guide パッケージで提供される Security Content Automation Protocol (SCAP) コンテンツに従うことを推奨します。

SCAP Security Guide パッケージは、SCAP 1.2 および SCAP 1.3 標準規格に準拠するコンテンツを提供します。openscap scanner ユーティリティーは、SCAP Security Guide パッケージで提供される SCAP 1.2 および SCAP 1.3 コンテンツの両方と互換性があります。

設定コンプライアンススキャンを実行しても、システムが準拠しているとは限りません。

SCAP Security Guide スイートは、データストリームドキュメントの形式で、複数のプラットフォームのプロファイルを提供します。データストリームは、定義、ベンチマーク、プロファイル、および個々のルールが含まれるファイルです。各ルールでは、コンプライアンスの適用性と要件を指定します。RHEL は、セキュリティーポリシーを扱う複数のプロファイルを提供します。Red Hat データストリームには、業界標準の他に、失敗したルールの修正に関する情報も含まれます。

コンプライアンススキャンリソースの構造

プロファイルは、OSPP、PCI-DSS、Health Insurance Portability and Accountability Act (HIPAA) などのセキュリティーポリシーに基づく一連のルールです。これにより、セキュリティー標準規格に準拠するために、システムを自動で監査できます。

プロファイルを変更 (調整) して、パスワードの長さなどの特定のルールをカスタマイズできます。プロファイルの調整の詳細は、SCAP Workbench を使用したセキュリティープロファイルのカスタマイズ を参照してください。

6.3.2. OpenSCAP スキャン結果の例

OpenSCAP スキャンに適用されるデータストリームとプロファイル、およびシステムのさまざまなプロパティーに応じて、各ルールから特定の結果が生成される場合があります。以下に考えられる結果とその意味の簡単な説明を示します。

- Pass

- スキャンでは、このルールとの競合が見つかりませんでした。

- Fail

- スキャンで、このルールとの競合が検出されました。

- Not checked

- OpenSCAP はこのルールの自動評価を実行しません。システムがこのルールに手動で準拠しているかどうかを確認してください。

- Not applicable

- このルールは、現在の設定には適用されません。

- Not selected

- このルールはプロファイルには含まれません。OpenSCAP はこのルールを評価せず、結果にこのようなルールは表示されません。

- Error

-

スキャンでエラーが発生しました。詳細は、

--verbose DEVELオプションを指定してoscapコマンドで確認できます。Red Hat カスタマーポータル でサポートケースを作成するか、Red Hat Jira の RHEL プロジェクト でチケットを作成します。 - Unknown

-

スキャンで予期しない状況が発生しました。詳細は、

`--verbose DEVELオプションを指定してoscapコマンドを入力できます。Red Hat カスタマーポータル でサポートケースを作成するか、Red Hat Jira の RHEL プロジェクト でチケットを作成します。

6.3.3. 設定コンプライアンスのプロファイルの表示

スキャンまたは修復にプロファイルを使用することを決定する前に、oscap info サブコマンドを使用して、プロファイルを一覧表示し、詳細な説明を確認できます。

前提条件

-

openscap-scannerパッケージおよびscap-security-guideパッケージがインストールされている。

手順

SCAP Security Guide プロジェクトが提供するセキュリティーコンプライアンスプロファイルで利用可能なファイルをすべて表示します。

ls /usr/share/xml/scap/ssg/content/ ssg-rhel9-ds.xml

$ ls /usr/share/xml/scap/ssg/content/ ssg-rhel9-ds.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow oscap infoサブコマンドを使用して、選択したデータストリームに関する詳細情報を表示します。データストリームを含む XML ファイルは、名前に-ds文字列で示されます。Profilesセクションでは、利用可能なプロファイルと、その ID のリストを確認できます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow データストリームファイルからプロファイルを選択し、選択したプロファイルに関する追加情報を表示します。そのためには、

oscap infoに--profileオプションを指定した後に、直前のコマンドの出力で表示された ID の最後のセクションを指定します。たとえば、HIPPA プロファイルの ID はxccdf_org.ssgproject.content_profile_hipaaで、--profileオプションの値はhipaaです。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.3.4. 特定のベースラインによる設定コンプライアンスの評価

oscap コマンドラインツールを使用して、システムまたはリモートシステムが特定のベースラインに準拠しているかどうかを判断し、結果をレポートに保存できます。

前提条件

-

openscap-scannerパッケージおよびscap-security-guideパッケージがインストールされている。 - システムが準拠する必要があるベースライン内のプロファイルの ID を知っている必要があります。ID を見つけるには、設定コンプライアンスのプロファイルの表示 セクションを参照してください。

手順

ローカルシステムをスキャンして、選択したプロファイルへの準拠を評価し、スキャン結果をファイルに保存します。

oscap xccdf eval --report <scan-report.html> --profile <profileID> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

$ oscap xccdf eval --report <scan-report.html> --profile <profileID> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のように置き換えます。

-

<scan-report.html>は、oscapがスキャン結果を保存するファイル名です。 -

<profileID>は、システムが準拠する必要があるプロファイル ID (例:hipaa) です。

-

オプション: リモートシステムをスキャンして、選択したプロファイルへの準拠を評価し、スキャン結果をファイルに保存します。

oscap-ssh <username>@<hostname> <port> xccdf eval --report <scan-report.html> --profile <profileID> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

$ oscap-ssh <username>@<hostname> <port> xccdf eval --report <scan-report.html> --profile <profileID> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のように置き換えます。

-

<username>@<hostname>は、リモートシステムのユーザー名とホスト名に置き換えます。 -

<port>は、リモートシステムにアクセスできるポート番号です。 -

<scan-report.html>は、oscapがスキャン結果を保存するファイル名です。 -

<profileID>は、システムが準拠する必要があるプロファイル ID (例:hipaa) です。

-

6.4. 特定のベースラインに合わせたシステムの修正

特定のベースラインに合わせて RHEL システムを修正できます。SCAP Security Guide で提供されるプロファイルに合わせてシステムを修正できます。使用可能なプロファイルのリストの詳細は、設定コンプライアンスのプロファイルの表示 を参照してください。

修正 オプションが有効な状態でのシステム評価は、慎重に行わないとシステムが機能不全に陥る場合があります。Red Hat は、セキュリティーを強化した修正で加えられた変更を元に戻す自動手段は提供していません。修復は、デフォルト設定の RHEL システムで対応しています。インストール後にシステムが変更した場合は、修正を実行しても、必要なセキュリティープロファイルに準拠しない場合があります。

前提条件

-

scap-security-guideパッケージがインストールされている。

手順

--remediateオプションを指定したoscapコマンドを使用してシステムを修復します。oscap xccdf eval --profile <profileID> --remediate /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

# oscap xccdf eval --profile <profileID> --remediate /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow <profileID>は、システムが準拠する必要があるプロファイル ID (例:hipaa) に置き換えます。- システムを再起動します。

検証

システムがプロファイルに準拠しているかどうかを評価し、スキャン結果をファイルに保存します。

oscap xccdf eval --report <scan-report.html> --profile <profileID> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

$ oscap xccdf eval --report <scan-report.html> --profile <profileID> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のように置き換えます。

-

<scan-report.html>は、oscapがスキャン結果を保存するファイル名です。 -

<profileID>は、システムが準拠する必要があるプロファイル ID (例:hipaa) です。

-

6.5. SSG Ansible Playbook を使用した特定のベースラインに合わせたシステムの修正

SCAP Security Guide プロジェクトの Ansible Playbook ファイルを使用して、特定のベースラインに合わせてシステムを修正できます。SCAP Security Guide によって提供されるすべてのプロファイルに合わせて修正できます。

Remediate オプションが有効な状態でのシステム評価は、慎重に行わないとシステムが機能不全に陥る場合があります。Red Hat は、セキュリティーを強化した修正で加えられた変更を元に戻す自動手段は提供していません。修復は、デフォルト設定の RHEL システムで対応しています。インストール後にシステムが変更した場合は、修正を実行しても、必要なセキュリティープロファイルに準拠しない場合があります。

前提条件

-

scap-security-guideパッケージがインストールされている。 -

ansible-coreパッケージがインストールされている。詳細は、Ansible インストールガイド を参照してください。 -

rhc-worker-playbookパッケージがインストールされている。 - システムの修正に使用するプロファイルの ID がわかっている。詳細は、設定コンプライアンスのプロファイルの表示 を参照してください。

手順

Ansible を使用して、選択したプロファイルに準拠するようにシステムを修正します。

ANSIBLE_COLLECTIONS_PATH=/usr/share/rhc-worker-playbook/ansible/collections/ansible_collections/ ansible-playbook -i "localhost," -c local /usr/share/scap-security-guide/ansible/rhel9-playbook-<profileID>.yml

# ANSIBLE_COLLECTIONS_PATH=/usr/share/rhc-worker-playbook/ansible/collections/ansible_collections/ ansible-playbook -i "localhost," -c local /usr/share/scap-security-guide/ansible/rhel9-playbook-<profileID>.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドで Playbook を実行するには、

ANSIBLE_COLLECTIONS_PATH環境変数が必要です。<profileID>は、選択したプロファイルのプロファイル ID に置き換えます。- システムを再起動します。

検証

システムが選択したプロファイルに準拠しているかどうかを評価し、スキャン結果をファイルに保存します。

oscap xccdf eval --profile <profileID> --report <scan-report.html> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

# oscap xccdf eval --profile <profileID> --report <scan-report.html> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow <scan-report.html>は、oscapがスキャン結果を保存するファイル名に置き換えます。

6.6. システムを特定のベースラインに合わせるための修復用 Ansible Playbook の作成

システムを特定のベースラインに合わせるために必要な修復のみを含む Ansible Playbook を作成できます。この Playbook は、すでに満たされている要件を含んでいないため、小型です。Playbook を作成しても、システムは一切変更されません。ここでは、後で適用するためのファイルを準備するだけです。

RHEL 9 では、Ansible Engine は、組み込みモジュールのみを含む ansible-core パッケージに置き換えられました。Ansible 修復の多くは、community コレクションおよび Portable Operating System Interface (POSIX) コレクションのモジュールを使用することに注意してください。これは組み込みモジュールには含まれていません。この場合は、Bash 修復を Ansible 修復の代わりに使用できます。RHEL 9.0 の Red Hat Connector には、修復 Playbook が Ansible Core で機能するために必要な Ansible モジュールが含まれています。

前提条件

-

scap-security-guideパッケージがインストールされている。 -

ansible-coreパッケージがインストールされている。詳細は、Ansible インストールガイド を参照してください。 -

rhc-worker-playbookパッケージがインストールされている。 - システムの修正に使用するプロファイルの ID がわかっている。詳細は、設定コンプライアンスのプロファイルの表示 を参照してください。

手順

システムをスキャンして結果を保存します。

oscap xccdf eval --profile <profileID> --results <profile-results.xml> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

# oscap xccdf eval --profile <profileID> --results <profile-results.xml> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 結果が含まれるファイルで、結果 ID の値を見つけます。

oscap info <profile-results.xml>

# oscap info <profile-results.xml>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ステップ 1 で生成されたファイルに基づいて Ansible Playbook を生成します。

oscap xccdf generate fix --fix-type ansible --result-id xccdf_org.open-scap_testresult_xccdf_org.ssgproject.content_profile_<profileID> --output <profile-remediations.yml> <profile-results.xml>

# oscap xccdf generate fix --fix-type ansible --result-id xccdf_org.open-scap_testresult_xccdf_org.ssgproject.content_profile_<profileID> --output <profile-remediations.yml> <profile-results.xml>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

生成された

<profile-remediations.yml>ファイルに、ステップ 1 で実行したスキャンで失敗したルールに対する Ansible 修復が含まれていることを確認します。 Ansible を使用して、選択したプロファイルに準拠するようにシステムを修正します。

ANSIBLE_COLLECTIONS_PATH=/usr/share/rhc-worker-playbook/ansible/collections/ansible_collections/ ansible-playbook -i "localhost," -c local <profile-remediations.yml>`

# ANSIBLE_COLLECTIONS_PATH=/usr/share/rhc-worker-playbook/ansible/collections/ansible_collections/ ansible-playbook -i "localhost," -c local <profile-remediations.yml>`Copy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドで Playbook を実行するには、

ANSIBLE_COLLECTIONS_PATH環境変数が必要です。警告Remediateオプションが有効な状態でのシステム評価は、慎重に行わないとシステムが機能不全に陥る場合があります。Red Hat は、セキュリティーハードニング関連の修復によって行われた変更を自動的に元に戻す方法は提供していません。修復は、デフォルト設定の RHEL システムで対応しています。インストール後にシステムが変更した場合は、修正を実行しても、必要なセキュリティープロファイルに準拠しない場合があります。

検証

システムが選択したプロファイルに準拠しているかどうかを評価し、スキャン結果をファイルに保存します。

oscap xccdf eval --profile <profileID> --report <scan-report.html> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

# oscap xccdf eval --profile <profileID> --report <scan-report.html> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow <scan-report.html>は、oscapがスキャン結果を保存するファイル名に置き換えます。

6.7. 後でアプリケーションを修復するための Bash スクリプトの作成

この手順を使用して、システムを HIPAA などのセキュリティープロファイルと調整する修正を含む Bash スクリプトを作成します。次の手順では、システムに変更を加えることなく、後のアプリケーション用にファイルを準備する方法を説明します。

前提条件

-

RHEL システムに、

scap-security-guideパッケージがインストールされている。

手順

oscapコマンドを使用してシステムをスキャンし、結果を XML ファイルに保存します。以下の例では、oscapはhipaaプロファイルに対してシステムを評価します。oscap xccdf eval --profile hipaa --results <hipaa-results.xml> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

# oscap xccdf eval --profile hipaa --results <hipaa-results.xml> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 結果が含まれるファイルで、結果 ID の値を見つけます。

oscap info <hipaa-results.xml>

# oscap info <hipaa-results.xml>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 手順 1 で生成された結果ファイルに基づいて Bash スクリプトを生成します。

oscap xccdf generate fix --fix-type bash --result-id <xccdf_org.open-scap_testresult_xccdf_org.ssgproject.content_profile_hipaa> --output <hipaa-remediations.sh> <hipaa-results.xml>

# oscap xccdf generate fix --fix-type bash --result-id <xccdf_org.open-scap_testresult_xccdf_org.ssgproject.content_profile_hipaa> --output <hipaa-remediations.sh> <hipaa-results.xml>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

<hipaa-remediations.sh>ファイルには、手順 1 で実行されたスキャン中に失敗したルールの修復が含まれます。この生成されたファイルを確認したら、このファイルと同じディレクトリー内で、./<hipaa-remediations.sh>コマンドを使用してファイルを適用できます。

検証

-

お使いのテキストエディターで、手順 1 で実行したスキャンで失敗したルールが

<hipaa-remediations.sh>ファイルに含まれていることを確認します。

6.8. SCAP Workbench を使用したカスタムプロファイルでシステムのスキャン

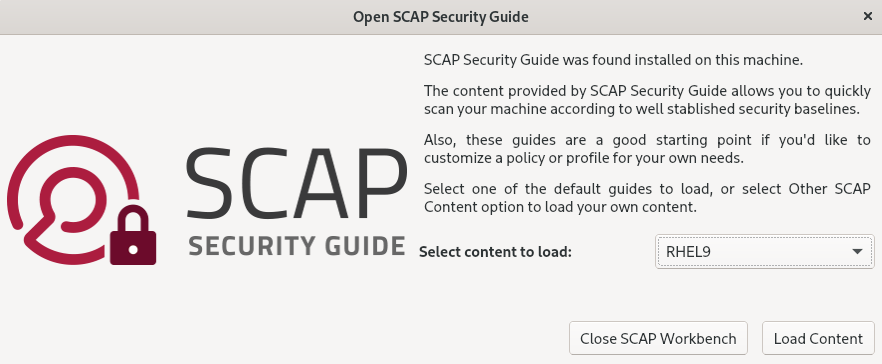

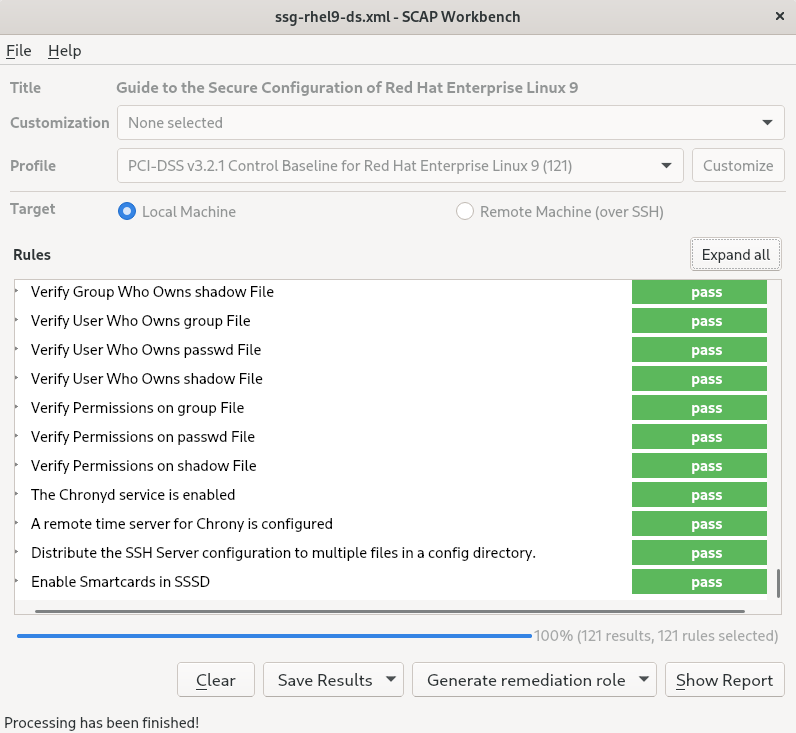

SCAP Workbench (scap-workbench) パッケージはグラフィカルユーティリティーで、1 台のローカルシステムまたはリモートシステムで設定スキャンと脆弱性スキャンを実行し、システムの修復を実行して、スキャン評価に基づくレポートを生成します。oscap コマンドラインユーティリティーとの比較は、SCAP Workbench には限定的な機能しかないことに注意してください。SCAP Workbench は、データストリームファイルの形式でセキュリティーコンテンツを処理します。

6.8.1. SCAP Workbench を使用したシステムのスキャンおよび修復

選択したセキュリティーポリシーに対してシステムを評価するには、以下の手順に従います。

前提条件

-

scap-workbenchパッケージがシステムにインストールされている。

手順

GNOME Classicデスクトップ環境からSCAP Workbenchを実行するには、Super キーを押してアクティビティーの概要を開き、scap-workbenchと入力して Enterを押します。または、次のコマンドを実行します。scap-workbench &

$ scap-workbench &Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のオプションのいずれかを使用してセキュリティーポリシーを選択します。

-

開始ウィンドウの

Load Contentボタン -

Open content from SCAP Security Guide FileメニューのOpen Other Contentで、XCCDF、SCAP RPM、またはデータストリームファイルの各ファイルを検索します。

-

開始ウィンドウの

チェックボックスを選択して、システム設定の自動修正を行うことができます。このオプションを有効にすると、

SCAP Workbenchは、ポリシーにより適用されるセキュリティールールに従ってシステム設定の変更を試みます。このプロセスは、システムスキャン時に失敗した関連チェックを修正する必要があります。警告修正オプションが有効な状態でのシステム評価は、慎重に行わないとシステムが機能不全に陥る場合があります。Red Hat は、セキュリティーを強化した修正で加えられた変更を元に戻す自動手段は提供していません。修復は、デフォルト設定の RHEL システムで対応しています。インストール後にシステムが変更した場合は、修正を実行しても、必要なセキュリティープロファイルに準拠しない場合があります。ボタンをクリックし、選択したプロファイルでシステムをスキャンします。

-

スキャン結果を XCCDF ファイル、ARF ファイル、または HTML ファイルの形式で保存するには、 コンボボックスをクリックします。

HTML Reportオプションを選択して、スキャンレポートを、人間が判読できる形式で生成します。XCCDF 形式および ARF (データストリーム) 形式は、追加の自動処理に適しています。3 つのオプションはすべて繰り返し選択できます。 - 結果ベースの修復をファイルにエクスポートするには、ポップアップメニューの を使用します。

6.8.2. SCAP Workbench を使用したセキュリティープロファイルのカスタマイズ

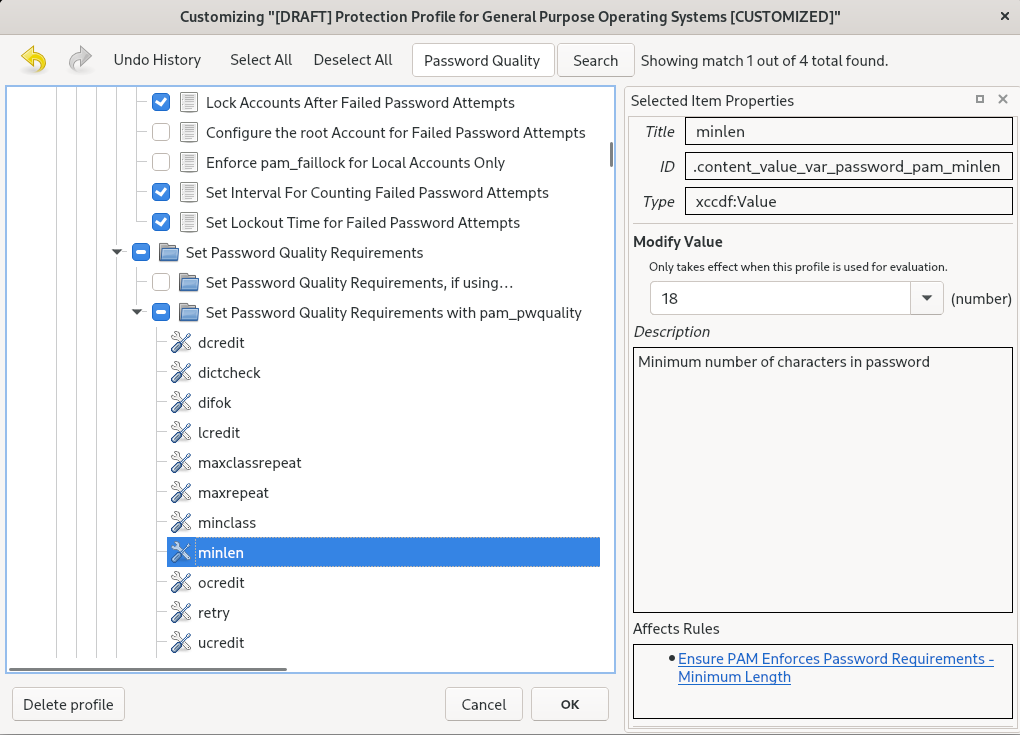

セキュリティープロファイルをカスタマイズするには、特定のルール (パスワードの最小長など) のパラメーターを変更し、別の方法で対象とするルールを削除し、追加のルールを選択して内部ポリシーを実装できます。プロファイルをカスタマイズして新しいルールの定義はできません。

以下の手順では、SCAP Workbench を使用してプロファイルをカスタマイズ (調整) します。oscap コマンドラインユーティリティーで使用するようにカスタマイズしたプロファイルを保存することもできます。

前提条件

-

scap-workbenchパッケージがシステムにインストールされている。

手順

-

SCAP Workbenchを実行し、Open content from SCAP Security GuideまたはFileメニューのOpen Other Contentを使用してカスタマイズするプロファイルを選択します。 選択したセキュリティープロファイルを必要に応じて調整するには、 ボタンをクリックします。

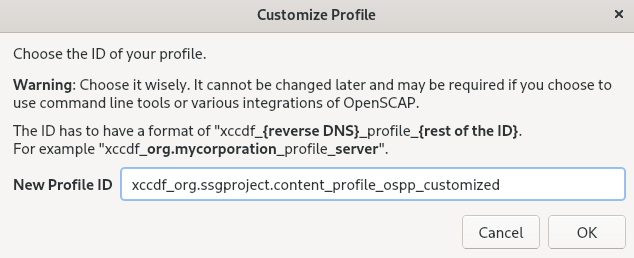

これにより、元のデータストリームファイルを変更せずに現在選択されているプロファイルを変更できる新しいカスタマイズウィンドウが開きます。新しいプロファイル ID を選択します。

- 論理グループに分けられたルールを持つツリー構造を使用するか、 フィールドを使用して変更するルールを検索します。

ツリー構造のチェックボックスを使用した include ルールまたは exclude ルール、または必要に応じてルールの値を変更します。

- ボタンをクリックして変更を確認します。

変更内容を永続的に保存するには、以下のいずれかのオプションを使用します。

-

FileメニューのSave Customization Onlyを使用して、カスタマイズファイルを別途保存します。 FileメニューSave Allを選択して、すべてのセキュリティーコンテンツを一度に保存します。Into a directoryオプションを選択すると、SCAP Workbenchは、データストリームファイルおよびカスタマイズファイルの両方を、指定した場所に保存します。これはバックアップソリューションとして使用できます。As RPMオプションを選択すると、SCAP Workbenchに、データストリームファイル、ならびにカスタマイズファイルを含む RPM パッケージの作成を指示できます。これは、リモートでスキャンできないシステムにセキュリティーコンテンツを配布したり、詳細な処理のためにコンテンツを配信するのに便利です。

-

-

SCAP Workbenchは、カスタマイズしたプロファイル向けの結果ベースの修正に対応していないため、oscapコマンドラインユーティリティーでエクスポートした修正を使用します。

6.9. インストール直後にセキュリティープロファイルに準拠するシステムのデプロイメント

OpenSCAP スイートを使用して、インストールプロセスの直後に、OSPP や PCI-DSS、HIPAA プロファイルなどのセキュリティープロファイルに準拠する RHEL システムをデプロイできます。このデプロイメント方法を使用すると、修正スクリプトを使用して後で適用できない特定のルール (パスワードの強度とパーティション化のルールなど) を適用できます。

6.9.1. Server with GUI と互換性のないプロファイル

SCAP Security Guide の一部として提供される一部のセキュリティープロファイルは、Server with GUI ベース環境に含まれる拡張パッケージセットと互換性がありません。したがって、次のいずれかのプロファイルに準拠するシステムをインストールする場合は、Server with GUI を選択しないでください。

| プロファイル名 | プロファイル ID | 理由 | 注記 |

|---|---|---|---|

| [ドラフト] CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Server |

|

パッケージ | |

| [ドラフト] CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Server |

|

パッケージ | |

| DISA STIG for Red Hat Enterprise Linux 9 |

|

パッケージ | RHEL システムを DISA STIG に準拠したServer with GUI としてインストールするには、DISA STIG with GUI プロファイルを使用できます (BZ#1648162) |

6.9.2. グラフィカルインストールを使用したベースライン準拠の RHEL システムのデプロイメント

この手順を使用して、特定のベースラインに合わせた RHEL システムをデプロイします。この例では、OSPP (Protection Profile for General Purpose Operating System) を使用します。

SCAP Security Guide の一部として提供される一部のセキュリティープロファイルは、Server with GUI ベース環境に含まれる拡張パッケージセットと互換性がありません。詳細は、GUI サーバーと互換性のないプロファイル を参照してください。

前提条件

-

グラフィカルインストールプログラムでシステムを起動している。OSCAP Anaconda アドオン はインタラクティブなテキストのみのインストールをサポートしていないことに注意してください。 -

インストール概要画面を開いている。

手順

-

インストール概要画面で、ソフトウェアの選択をクリックします。ソフトウェアの選択画面が開きます。 -

ベース環境ペインで、サーバー環境を選択します。ベース環境は、1 つだけ選択できます。 -

完了をクリックして設定を適用し、インストール概要画面に戻ります。 -

OSPP には、準拠する必要がある厳密なパーティション分割要件があるため、

/boot、/home、/var、/tmp、/var/log、/var/tmp、および/var/log/auditにそれぞれパーティションを作成します。 -

セキュリティーポリシーをクリックします。セキュリティーポリシー画面が開きます。 -

システムでセキュリティーポリシーを有効にするには、

セキュリティーポリシーの適用をONに切り替えます。 -

プロファイルペインで

Protection Profile for General Purpose Operating Systemsプロファイルを選択します。 -

プロファイルの選択をクリックして選択を確定します。 -

画面下部に表示される

Changes that were done or need to be doneの変更を確定します。残りの手動変更を完了します。 グラフィカルインストールプロセスを完了します。

注記グラフィカルインストールプログラムは、インストールに成功すると、対応するキックスタートファイルを自動的に作成します。

/root/anaconda-ks.cfgファイルを使用して、OSPP 準拠のシステムを自動的にインストールできます。

検証

インストール完了後にシステムの現在のステータスを確認するには、システムを再起動して新しいスキャンを開始します。

oscap xccdf eval --profile ospp --report eval_postinstall_report.html /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

# oscap xccdf eval --profile ospp --report eval_postinstall_report.html /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.9.3. キックスタートを使用したベースライン準拠の RHEL システムのデプロイメント

特定のベースラインに準拠した RHEL システムをデプロイできます。この例では、OSPP (Protection Profile for General Purpose Operating System) を使用します。

前提条件

-

RHEL 9 システムに、

scap-security-guideパッケージがインストールされている。

手順

-

キックスタートファイル

/usr/share/scap-security-guide/kickstart/ssg-rhel9-ospp-ks.cfgを、選択したエディターで開きます。 -

設定要件を満たすように、パーティション設定スキームを更新します。OSPP に準拠するには、

/boot、/home、/var、/tmp、/var/log、/var/tmp、および/var/log/auditの個別のパーティションを保持する必要があります。パーティションのサイズのみ変更することができます。 - キックスタートを使用した自動インストールの実行 の説明に従って、キックスタートインストールを開始します。

キックスタートファイルのパスワードでは、OSPP の要件が確認されていません。

検証

インストール完了後にシステムの現在のステータスを確認するには、システムを再起動して新しいスキャンを開始します。

oscap xccdf eval --profile ospp --report eval_postinstall_report.html /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

# oscap xccdf eval --profile ospp --report eval_postinstall_report.html /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.10. コンテナーおよびコンテナーイメージの脆弱性スキャン

以下の手順を使用して、コンテナーまたはコンテナーイメージのセキュリティー脆弱性を検索します。

前提条件

-

openscap-utilsおよびbzip2パッケージがインストールされます。

手順

システムに最新 RHSA OVAL 定義をダウンロードします。

wget -O - https://www.redhat.com/security/data/oval/v2/RHEL9/rhel-9.oval.xml.bz2 | bzip2 --decompress > rhel-9.oval.xml

# wget -O - https://www.redhat.com/security/data/oval/v2/RHEL9/rhel-9.oval.xml.bz2 | bzip2 --decompress > rhel-9.oval.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンテナーまたはコンテナーイメージの ID を取得します。以下に例を示します。

podman images REPOSITORY TAG IMAGE ID CREATED SIZE registry.access.redhat.com/ubi9/ubi latest 096cae65a207 7 weeks ago 239 MB

# podman images REPOSITORY TAG IMAGE ID CREATED SIZE registry.access.redhat.com/ubi9/ubi latest 096cae65a207 7 weeks ago 239 MBCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンテナーまたはコンテナーイメージで脆弱性をスキャンし、結果を vulnerability.html ファイルに保存します。

oscap-podman 096cae65a207 oval eval --report vulnerability.html rhel-9.oval.xml

# oscap-podman 096cae65a207 oval eval --report vulnerability.html rhel-9.oval.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow oscap-podmanコマンドには root 権限が必要で、コンテナーの ID は最初の引数であることに注意してください。

検証

結果をブラウザーで確認します。以下に例を示します。

firefox vulnerability.html &

$ firefox vulnerability.html &Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.11. 特定のベースラインを使用したコンテナーまたはコンテナーイメージのセキュリティーコンプライアンスの評価

コンテナーまたはコンテナーイメージが、Operating System Protection Profile (OSPP)、Payment Card Industry Data Security Standard (PCI-DSS)、Health Insurance Portability and Accountability Act (HIPAA) などの特定のセキュリティーベースラインに準拠しているかどうかを評価できます。

前提条件

-

openscap-utilsパッケージおよびscap-security-guideパッケージがインストールされている。 - システムへの root アクセス権があります。

手順

コンテナーまたはコンテナーイメージの ID を見つけます。

-

コンテナーの ID を見つけるには、

podman ps -aコマンドを入力します。 -

コンテナーイメージの ID を見つけるには、

podman imagesコマンドを入力します。

-

コンテナーの ID を見つけるには、

コンテナーまたはコンテナーイメージがプロファイルに準拠しているかどうかを評価し、スキャン結果をファイルに保存します。

oscap-podman <ID> xccdf eval --report <scan-report.html> --profile <profileID> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

# oscap-podman <ID> xccdf eval --report <scan-report.html> --profile <profileID> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のように置き換えます。

-

<ID>は、コンテナーまたはコンテナーイメージの ID です。 -

<scan-report.html>は、oscapがスキャン結果を保存するファイル名です。 -

<profileID>は、システムが準拠する必要があるプロファイル ID (例:hipaa、ospp、pci-dss) です。

-

検証

結果をブラウザーで確認します。以下に例を示します。

firefox <scan-report.html> &

$ firefox <scan-report.html> &Copy to Clipboard Copied! Toggle word wrap Toggle overflow

notapplicable とマークされたルールは、ベアメタルおよび仮想化システムにのみ適用され、コンテナーまたはコンテナーイメージには適用されません。

6.12. RHEL 9 でサポートされる SCAP Security Guide プロファイル

RHEL の特定のマイナーリリースで提供される SCAP コンテンツだけを使用してください。これは、ハードニングに関与するコンポーネントが新しい機能で更新されることがあるためです。SCAP コンテンツは、この更新を反映するように変更されますが、以前のバージョンと互換性があるとは限りません。

oscap info コマンドを使用すると、システムにインストールされている scap-security-guide RPM のバージョンに関連する情報を取得できます。詳細は、設定コンプライアンスのプロファイルの表示 を参照してください。

以下の表では、RHEL 9 で提供されるプロファイルと、プロファイルが適合するポリシーのバージョンを紹介しています。

| プロファイル名 | プロファイル ID | ポリシーバージョン |

|---|---|---|

| Security of Information Systems (ANSSI) BP-028 Enhanced Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 High Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Intermediary Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Minimal Level |

| 2.0 |

| CCN Red Hat Enterprise Linux 9 - Advanced |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - Basic |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - Intermediate |

| 2022-10 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Server |

| 2.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Server |

| 2.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Workstation |

| 2.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Workstation |

| 2.0.0 |

| [ドラフト] Unclassified Information in Non-federal Information Systems and Organizations (NIST 800-171) |

| r2 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| バージョン付けなし |

| Health Insurance Portability and Accountability Act (HIPAA) |

| バージョン付けなし |

| Australian Cyber Security Centre (ACSC) ISM Official |

| バージョン付けなし |

| Protection Profile for General Purpose Operating Systems |

| 4.3 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 9 |

| 4.0.1 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) for Red Hat Enterprise Linux 9 |

| V2R3 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) with GUI for Red Hat Enterprise Linux 9 |

| V2R3 |

| プロファイル名 | プロファイル ID | ポリシーバージョン |

|---|---|---|

| Security of Information Systems (ANSSI) BP-028 Enhanced Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 High Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Intermediary Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Minimal Level |

| 2.0 |

| CCN Red Hat Enterprise Linux 9 - Advanced |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - Basic |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - Intermediate |

| 2022-10 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Server |

| 2.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Server |

| 2.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Workstation |

| 2.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Workstation |

| 2.0.0 |

| [ドラフト] Unclassified Information in Non-federal Information Systems and Organizations (NIST 800-171) |

| r2 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| バージョン付けなし |

| Health Insurance Portability and Accountability Act (HIPAA) |

| バージョン付けなし |

| Australian Cyber Security Centre (ACSC) ISM Official |

| バージョン付けなし |

| Protection Profile for General Purpose Operating Systems |

| 4.3 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 9 |

|

RHEL9.5.0: 4.0 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) for Red Hat Enterprise Linux 9 |

| V2R3 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) with GUI for Red Hat Enterprise Linux 9 |

| V2R3 |

| プロファイル名 | プロファイル ID | ポリシーバージョン |

|---|---|---|

| Security of Information Systems (ANSSI) BP-028 Enhanced Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 High Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Intermediary Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Minimal Level |

| 2.0 |

| CCN Red Hat Enterprise Linux 9 - Advanced |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - Basic |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - Intermediate |

| 2022-10 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Server |

|

RHEL 9.4.0 から RHEL 9.4.2: 1.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Server |

|

RHEL 9.4.0 から RHEL 9.4.2: 1.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Workstation |

|

RHEL 9.4.0 から RHEL 9.4.2: 1.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Workstation |

|

RHEL 9.4.0 から RHEL 9.4.2: 1.0.0 |

| [ドラフト] Unclassified Information in Non-federal Information Systems and Organizations (NIST 800-171) |

| r2 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| バージョン付けなし |

| Health Insurance Portability and Accountability Act (HIPAA) |

| バージョン付けなし |

| Australian Cyber Security Centre (ACSC) ISM Official |

| バージョン付けなし |

| Protection Profile for General Purpose Operating Systems |

| 4.3 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 9 |

|

RHEL 9.4.0 から RHEL 9.4.4: 4.0 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) for Red Hat Enterprise Linux 9 |

| V2R3 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) with GUI for Red Hat Enterprise Linux 9 |

| V2R3 |

| プロファイル名 | プロファイル ID | ポリシーバージョン |

|---|---|---|

| Security of Information Systems (ANSSI) BP-028 Enhanced Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 High Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Intermediary Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Minimal Level |

| 2.0 |

| CCN Red Hat Enterprise Linux 9 - Advanced |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - Basic |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - Intermediate |

| 2022-10 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Server |

| 1.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Server |

| 1.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Workstation |

| 1.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Workstation |

| 1.0.0 |

| [ドラフト] Unclassified Information in Non-federal Information Systems and Organizations (NIST 800-171) |

| r2 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| バージョン付けなし |

| Health Insurance Portability and Accountability Act (HIPAA) |

| バージョン付けなし |

| Australian Cyber Security Centre (ACSC) ISM Official |

| バージョン付けなし |

| Protection Profile for General Purpose Operating Systems |

| 4.3 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 9 |

|

RHEL 9.3.0 から RHEL 9.3.2:3.2.1 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) for Red Hat Enterprise Linux 9 |

|

RHEL 9.3.0: ドラフト[a] |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) with GUI for Red Hat Enterprise Linux 9 |

|

RHEL 9.3.0: ドラフト[a] |

[a]

DISA は RHEL 9 の公式ベンチマークを公開していません。

| ||

| プロファイル名 | プロファイル ID | ポリシーバージョン |

|---|---|---|

| Security of Information Systems (ANSSI) BP-028 Enhanced Level |

|

RHEL 9.2.0 から RHEL 9.2.2: 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 High Level |

|

RHEL 9.2.0 から RHEL 9.2.2: 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Intermediary Level |

|

RHEL 9.2.0 から RHEL 9.2.2: 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Minimal Level |

|

RHEL 9.2.0 から RHEL 9.2.2: 1.2 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Server |

|

RHEL 9.2.0 から RHEL 9.2.10: 1.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Server |

|

RHEL 9.2.0 から RHEL 9.2.10: 1.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Workstation |

|

RHEL 9.2.0 から RHEL 9.2.10: 1.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Workstation |

|

RHEL 9.2.0 から RHEL 9.2.10: 1.0.0 |

| [ドラフト] Unclassified Information in Non-federal Information Systems and Organizations (NIST 800-171) |

| r2 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| バージョン付けなし |

| Health Insurance Portability and Accountability Act (HIPAA) |

| バージョン付けなし |

| Australian Cyber Security Centre (ACSC) ISM Official |

| バージョン付けなし |

| Protection Profile for General Purpose Operating Systems |

| 4.2.1 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 9 |

|

RHEL 9.2.0 から RHEL 9.2.5: 3.2.1 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) for Red Hat Enterprise Linux 9 |

| V2R3 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) with GUI for Red Hat Enterprise Linux 9 |

| V2R3 |

| CCN Red Hat Enterprise Linux 9 - Basic |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - Intermediate |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - Advanced |

| 2022-10 |

| プロファイル名 | プロファイル ID | ポリシーバージョン |

|---|---|---|

| Security of Information Systems (ANSSI) BP-028 Enhanced Level |

| 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 High Level |

| 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Intermediary Level |

| 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Minimal Level |

| 1.2 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Server |

|

RHEL 9.1.0 および RHEL 9.1.1: ドラフト[a] |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Server |

|

RHEL 9.1.0 および RHEL 9.1.1: ドラフト[a] |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Workstation |

|

RHEL 9.1.0 および RHEL 9.1.1: ドラフト[a] |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Workstation |

|

RHEL 9.1.0 および RHEL 9.1.1: ドラフト[a] |

| [ドラフト] Unclassified Information in Non-federal Information Systems and Organizations (NIST 800-171) |

| r2 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| バージョン付けなし |

| Health Insurance Portability and Accountability Act (HIPAA) |

| バージョン付けなし |

| Australian Cyber Security Centre (ACSC) ISM Official |

| バージョン付けなし |

| Protection Profile for General Purpose Operating Systems |

| 4.2.1 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 9 |

| 3.2.1 |

| [ドラフト] The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) for Red Hat Enterprise Linux 9 |

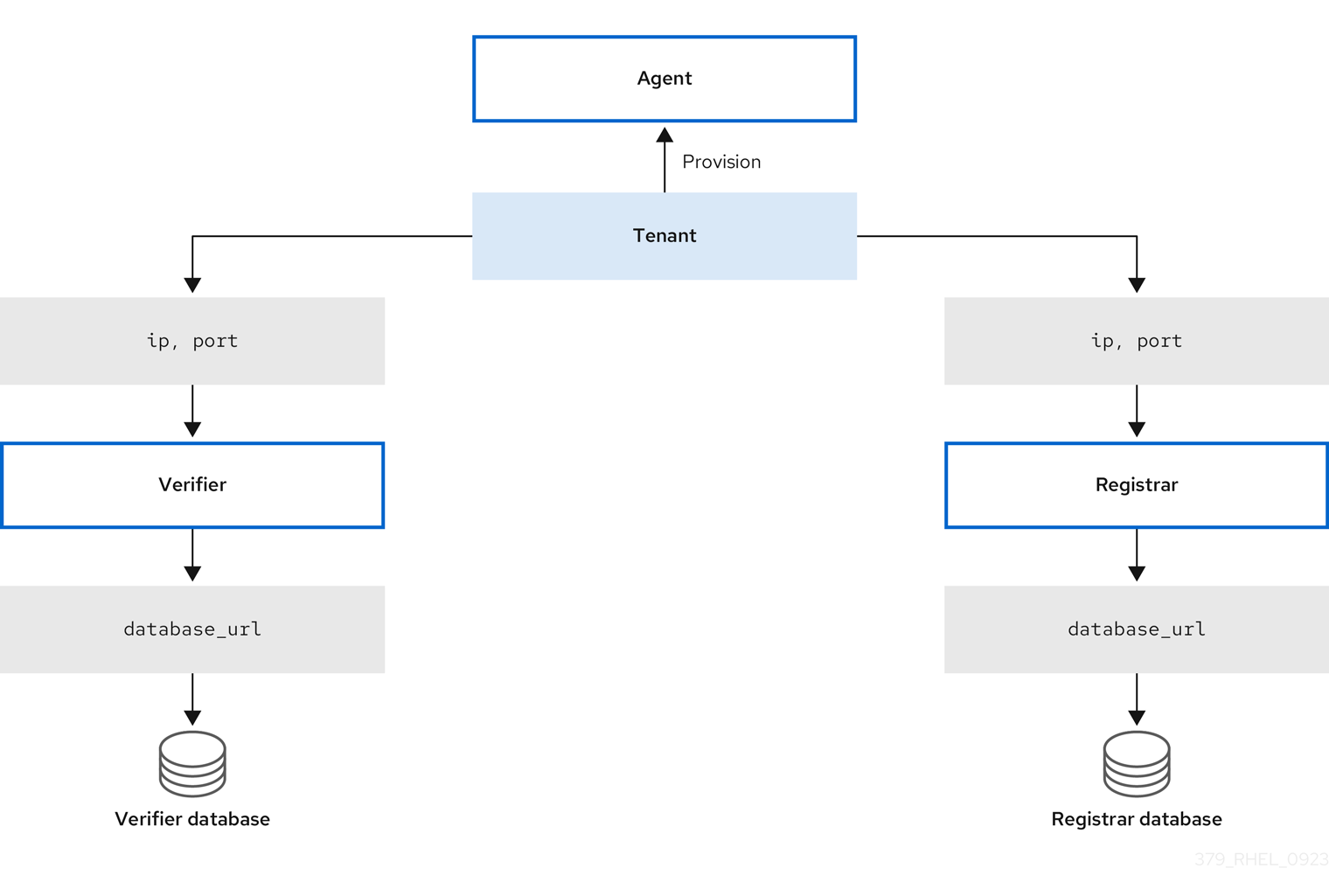

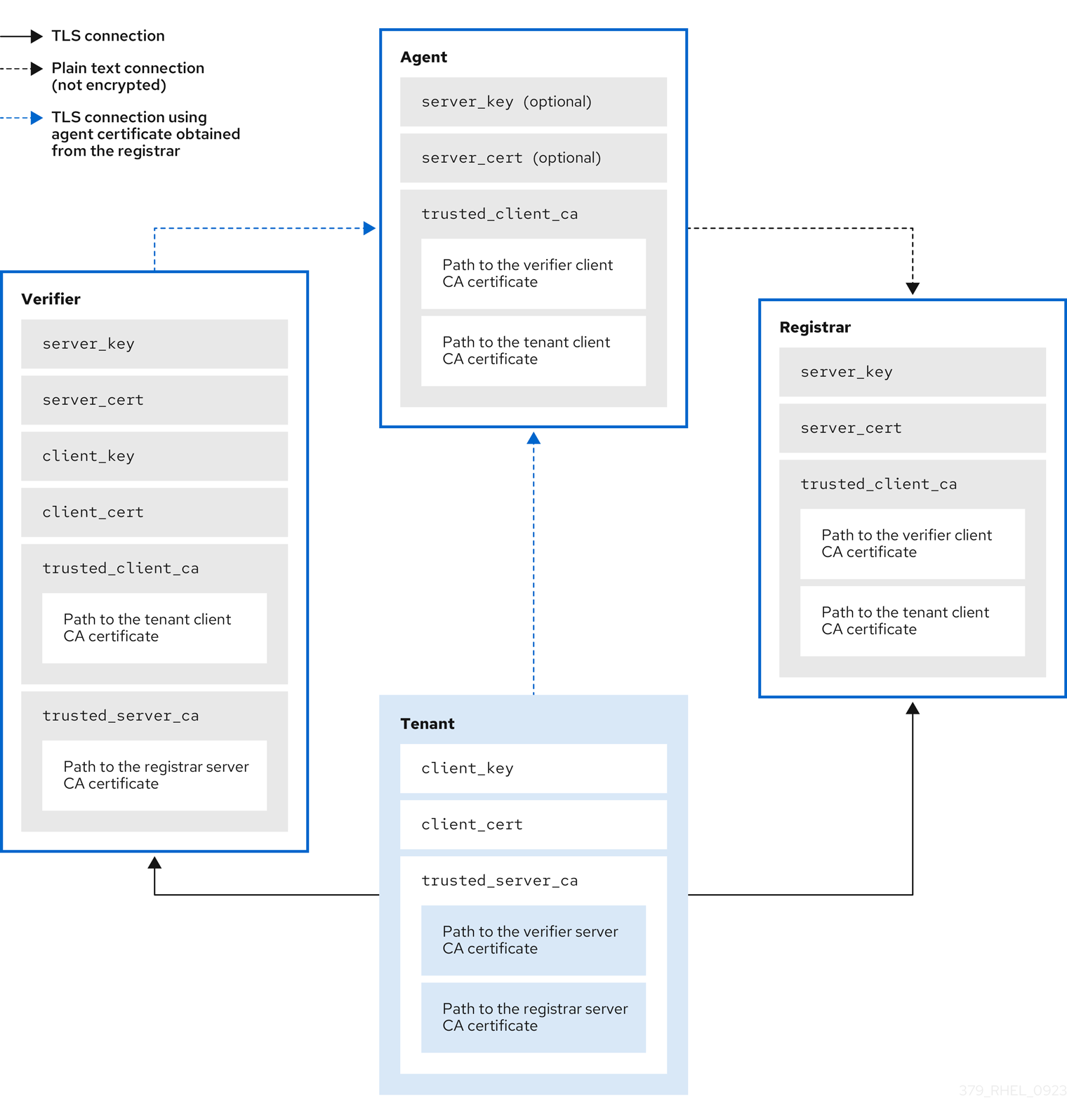

| ドラフト[a] |