インストールガイド

Red Hat Gluster Storage 3.5 のインストール

概要

第1章 Red Hat Gluster Storage のインストール計画

1.1. Red Hat Gluster Storage について

Red Hat Gluster Storage Server for On-Premise

Red Hat Gluster Storage Server for On-Premise を使用すると、企業は、コモディティーサーバーおよびストレージハードウェアを使用し、物理ストレージを仮想化された、スケーラブルな、かつ一元管理されるストレージプールとして処理できます。

Red Hat Gluster Storage Server for Public Cloud

Red Hat Gluster Storage Server for Public Cloud は、AWS パブリッククラウドでスケーラブルな NAS をデプロイするために GlusterFS を Amazon Machine Image (AMI) としてパッケージ化します。この強力なストレージサーバーは、Amazon ユーザー向けに、可用性が高く、スケーラブルで仮想化および一元管理されたストレージのプールを提供します。

ストレージノード

ストレージノードは、Red Hat Gluster Storage の 1 つのインスタンスを実行する物理サーバー、仮想マシン、またはパブリッククラウドイメージです。

1.2. 前提条件

1.2.1. マルチサイトクラスターのレイテンシー

ping -c100 -q site_ip_address/site_hostname

# ping -c100 -q site_ip_address/site_hostname1.2.2. ファイルシステムの要件

ext3 または ext4 を使用している既存の Gluster Storage Software Appliance のお客様が、XFS バックエンドファイルシステムを使用してサポートされているバージョンの Red Hat Gluster Storage にアップグレードできるよう支援します。

1.2.3. 論理ボリュームマネージャー

1.2.4. ネットワーク時間の設定

1.2.4.1. chrony を使用した時間同期の設定

clockdiff node-hostname

# clockdiff node-hostname1.2.4.2. Network Time Protocol を使用した時間同期の設定

ntpd デーモンを設定します。

- vim、nano などのテキストエディターで NTP 設定ファイル

/etc/ntp.confを編集します。nano /etc/ntp.conf

# nano /etc/ntp.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 以下のように、

ntp.confファイル内のパブリック NTP サーバーの一覧を追加または編集します。server 0.rhel.pool.ntp.org server 1.rhel.pool.ntp.org server 2.rhel.pool.ntp.org

server 0.rhel.pool.ntp.org server 1.rhel.pool.ntp.org server 2.rhel.pool.ntp.orgCopy to Clipboard Copied! Toggle word wrap Toggle overflow このファイルの Red Hat Enterprise Linux 6 バージョンには、すでに必要な情報が含まれています。カスタマイズが必要な場合は、このファイルの内容を編集します。特定の Red Hat Gluster Storage リリースについてサポートされる Red Hat Enterprise Linux バージョンについての詳細は、「Red Hat Gluster Storage のサポートマトリックス」を参照してください。 - オプションで、iburst ディレクティブを各行に追加して、初期の同期速度を引き上げます。

server 0.rhel.pool.ntp.org iburst server 1.rhel.pool.ntp.org iburst server 2.rhel.pool.ntp.org iburst

server 0.rhel.pool.ntp.org iburst server 1.rhel.pool.ntp.org iburst server 2.rhel.pool.ntp.org iburstCopy to Clipboard Copied! Toggle word wrap Toggle overflow - サーバーの一覧について完了したら、同じファイルに必要なパーミッションを設定します。

localhostにのみ無制限のアクセスがあることを確認します。restrict default kod nomodify notrap nopeer noquery restrict -6 default kod nomodify notrap nopeer noquery restrict 127.0.0.1 restrict -6 ::1

restrict default kod nomodify notrap nopeer noquery restrict -6 default kod nomodify notrap nopeer noquery restrict 127.0.0.1 restrict -6 ::1Copy to Clipboard Copied! Toggle word wrap Toggle overflow - すべての変更を保存してエディターを終了し、NTP デーモンを再起動します。

service ntpd restart

# service ntpd restartCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 起動時に ntpd デーモンが起動することを確認します。

chkconfig ntpd on

# chkconfig ntpd onCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.3. ハードウェアの互換性

1.4. ポート情報

iptables -A INPUT -m state --state NEW -m tcp -p tcp --dport 5667 -j ACCEPT service iptables save

# iptables -A INPUT -m state --state NEW -m tcp -p tcp --dport 5667 -j ACCEPT

# service iptables savefirewall-cmd --zone=zone_name --add-service=glusterfs firewall-cmd --zone=zone_name --add-service=glusterfs --permanent

# firewall-cmd --zone=zone_name --add-service=glusterfs

# firewall-cmd --zone=zone_name --add-service=glusterfs --permanentfirewall-cmd --zone=zone_name --add-port=port/protocol firewall-cmd --zone=zone_name --add-port=port/protocol --permanent

# firewall-cmd --zone=zone_name --add-port=port/protocol

# firewall-cmd --zone=zone_name --add-port=port/protocol --permanentfirewall-cmd --zone=public --add-port=5667/tcp firewall-cmd --zone=public --add-port=5667/tcp --permanent

# firewall-cmd --zone=public --add-port=5667/tcp

# firewall-cmd --zone=public --add-port=5667/tcp --permanent| 接続ソース | TCP ポート | UDP ポート | 推奨 | 用途 |

|---|---|---|---|---|

| 有効な SSH キーを持つ認証されたネットワークエンティティー | 22 | - | すべての設定 | geo レプリケーションを使用したリモートバックアップ |

| 認証されたネットワークエンティティー。他の RPC サービスと競合しないように注意してください。 | 111 | 111 | すべての設定 | RPC ポートマッパーおよび RPC バインド |

| 認証された SMB/CIFS クライアント | 139 および 445 | 137 および 138 | SMB/CIFS を使用したストレージの共有 | SMB/CIFS プロトコル |

| 認証された NFS クライアント | 2049 | 2049 | Gluster NFS(非推奨)または NFS-Ganesha を使用したストレージの共有 | NFS プロトコルを使用したエクスポート |

| Samba-CTDB クラスターのすべてのサーバー | 4379 | - | SMB および Gluster NFS を使用したストレージの共有(非推奨) | CTDB |

| 認証されたネットワークエンティティー | 24007 | - | すべての設定 | glusterd を使用した管理プロセス |

| 認証されたネットワークエンティティー | 24009 | - | すべての設定 | Gluster イベントデーモン |

| NFSv3 クライアント | 662 | 662 | NFS-Ganesha および Gluster NFS を使用したストレージの共有(非推奨) | statd |

| NFSv3 クライアント | 32803 | 32803 | NFS-Ganesha および Gluster NFS を使用したストレージの共有(非推奨) | NLM プロトコル |

| マウント要求を送信する NFSv3 クライアント | - | 32769 | Gluster NFS を使用したストレージの共有(非推奨) | Gluster NFS MOUNT プロトコル |

| マウント要求を送信する NFSv3 クライアント | 20048 | 20048 | NFS-Ganesha を使用したストレージの共有 | NFS-Ganesha MOUNT プロトコル |

| NFS クライアント | 875 | 875 | NFS-Ganesha を使用したストレージの共有 | NFS-Ganesha RQUOTA プロトコル(クォータ情報の取得) |

| pacemaker/corosync クラスターのサーバー | 2224 | - | NFS-Ganesha を使用したストレージの共有 | pcsd |

| pacemaker/corosync クラスターのサーバー | 3121 | - | NFS-Ganesha を使用したストレージの共有 | pacemaker_remote |

| pacemaker/corosync クラスターのサーバー | - | 5404 および 5405 | NFS-Ganesha を使用したストレージの共有 | corosync |

| pacemaker/corosync クラスターのサーバー | 21064 | - | NFS-Ganesha を使用したストレージの共有 | dlm |

| 認証されたネットワークエンティティー | 49152 - 49664 | - | すべての設定 | ブリック通信ポート必要なポートの合計数は、ノード上のブリックの数によって異なります。マシンのブリックごとに 1 つのポートが必要です。 |

| 接続ソース | TCP ポート | UDP ポート | 推奨 | 用途 |

|---|---|---|---|---|

| NFSv3 サーバー | 662 | 662 | NFS-Ganesha および Gluster NFS を使用したストレージの共有(非推奨) | statd |

| NFSv3 サーバー | 32803 | 32803 | NFS-Ganesha および Gluster NFS を使用したストレージの共有(非推奨) | NLM プロトコル |

1.5. Red Hat Gluster Storage のソフトウェアコンポーネントおよびバージョン

| RHGS バージョン | glusterfs および glusterfs-fuse | RHGS op-version | SMB | NFS | gDeploy | Ansible |

|---|---|---|---|---|---|---|

| 3.4 | 3.12.2-18 | 31302 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0 | gdeploy-2.0.2-27 | - |

| 3.4 Batch 1 更新 | 3.12.2-25 | 31303 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0 | gdeploy-2.0.2-30 | - |

| 3.4 Batch 2 更新 | 3.12.2-32 | 31304 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0 | gdeploy-2.0.2-31 | gluster-ansible-infra-1.0.2-2 |

| 3.4 Batch 3 更新 | 3.12.2-40 | 31305 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0 | gdeploy-2.0.2-31 | gluster-ansible-infra-1.0.2-2 |

| 3.4 Batch 4 更新 | 3.12.2-47 | 31305 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0 | gdeploy-2.0.2-32 | gluster-ansible-infra-1.0.3-3 |

| 3.4.4 非同期更新 | 3.12.2-47.5 | 31306 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0 | gdeploy-2.0.2-32 | gluster-ansible-infra-1.0.3-3 |

| 3.5 (RHEL 6) | 6.0-22 | 70000 | SMB 1、2.0、2.1、3.0、3.1.1 | - | - | - |

| 3.5 (RHEL 7) | 6.0-21 | 70000 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-2.0.2-35 | gluster-ansible-infra-1.0.4-3 |

| 3.5 Batch 更新 1 (RHEL 7) | 6.0-29 | 70000 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-2.0.2-35 | gluster-ansible-infra-1.0.4-5 |

| 3.5 非同期更新 (RHEL 7) | 6.0-30.1 | 70000 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-2.0.2-35 | gluster-ansible-infra-1.0.4-5 |

| 3.5 Batch 2 更新 (RHEL 7) | 6.0-37 | 70000 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-2.0.2-35 | gluster-ansible-infra-1.0.4-5 |

| 3.5 Batch 2 更新 (RHEL 8) | 6.0-37 | 70000 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-3.0.0-7 | gluster-ansible-infra-1.0.4-10 |

| 3.5.2 非同期更新 (RHEL 7) | 6.0-37.1 | 70000 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-2.0.2-35 | gluster-ansible-infra-1.0.4-5 |

| 3.5.2 非同期更新 (RHEL 8) | 6.0-37.1 | 70000 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-3.0.0-7 | gluster-ansible-infra-1.0.4-17 |

| 3.5 Batch 3 更新 (RHEL 7) | 6.0-49.2 | 70000 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-2.0.2-36 | gluster-ansible-infra-1.0.4-5 |

| 3.5 Batch 3 更新 (RHEL 8) | 6.0-49 | 70000 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-3.0.0-8 | gluster-ansible-infra-1.0.4-11 |

| 3.5 Batch 4 更新 (RHEL 7) | 6.0-56 | 70100 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-2.0.2-36 | gluster-ansible-infra-1.0.4-5 |

| 3.5 Batch 4 更新 (RHEL 8) | 6.0-56 | 70100 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-3.0.0-8 | gluster-ansible-infra-1.0.4-19 |

| 3.5.4 非同期更新 (RHEL 7) | 6.0-56.2 | 70100 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-2.0.2-36 | gluster-ansible-infra-1.0.4-19 |

| 3.5.4 非同期更新 (RHEL 8) | 6.0-56.2 | 70100 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-2.0.2-36 | gluster-ansible-infra-1.0.4-19 |

| 3.5 Batch 5 更新 (RHEL 7) | 6.0-59 | 70200 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-2.0.2-36 | gluster-ansible-infra-1.0.4-19 |

| 3.5 Batch 5 更新 (RHEL 8) | 6.0-59 | 70200 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-3.0.0-8 | gluster-ansible-infra-1.0.4-19 |

| 3.5 Batch 6 更新 (RHEL 7) | 6.0-61 | 70200 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-2.0.2-36 | gluster-ansible-infra-1.0.4-19 |

| 3.5 Batch 6 更新 (RHEL 8) | 6.0-61 | 70200 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-3.0.0-8 | gluster-ansible-infra-1.0.4-19 |

| 3.5 Batch 7 更新 (RHEL 7) | 6.0-63 | 70200 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-2.0.2-36 | gluster-ansible-infra-1.0.4-19 |

| 3.5 Batch 7 更新 (RHEL 8) | 6.0-63 | 70200 | SMB 1、2.0、2.1、3.0、3.1.1 | NFSv3、NFSv4.0、NFSv4.1 | gdeploy-3.0.0-11 | gluster-ansible-infra-1.0.4-21 |

1.6. 機能互換性サポート

| 機能 | バージョン |

|---|---|

| Arbiter ブリック | 3.2 |

| Bitrot 検出 | 3.1 |

| Erasure コーディング | 3.1 |

| Google Compute Engine | 3.1.3 |

| メタデータのキャッシュ | 3.2 |

| Microsoft Azure | 3.1.3 |

| NFS バージョン 4 | 3.1 |

| SELinux | 3.1 |

| シャード化 | 3.2.0 |

| スナップショット | 3.0 |

| スナップショット、クローン作成 | 3.1.3 |

| スナップショット、ユーザーサービスが可能 | 3.0.3 |

| 階層化 (Tiering)(非推奨) | 3.1.2 |

| Volume Shadow Copy (VSS) | 3.1.3 |

| ボリュームタイプ | シャード化 | 階層化 (Tiering)(非推奨) | クォータ | スナップショット | geo-レプリケーション | Bitrot |

|---|---|---|---|---|---|---|

| Arbitrated-Replicated | はい | いいえ | はい | はい | はい | はい |

| Distributed (分散) | いいえ | はい | はい | はい | はい | はい |

| Distributed-Dispersed | いいえ | はい | はい | はい | はい | はい |

| Distributed-Replicated | はい | はい | はい | はい | はい | はい |

| Replicated (レプリケート) | はい | はい | はい | はい | はい | はい |

| シャード化 | 該当なし | いいえ | いいえ | いいえ | はい | いいえ |

| 階層化 (Tirered)(非推奨) | いいえ | 該当なし | 限定的[a] | 限定的 [a] | 限定的 [a] | 限定的 [a] |

| 機能 | FUSE | gluster-NFS | NFS-Ganesha | SMB |

|---|---|---|---|---|

| Arbiter | はい | はい | はい | はい |

| Bitrot 検出 | はい | はい | いいえ | はい |

| dm-cache | はい | はい | はい | はい |

| 暗号化 (TLS-SSL) | はい | はい | はい | はい |

| Erasure コーディング | はい | はい | はい | はい |

| Export サブディレクトリー | はい | はい | はい | 該当なし |

| geo-レプリケーション | はい | はい | はい | はい |

| クォータ(非推奨)

警告

QUOTA 機能の使用は、Red Hat Gluster Storage 3.5.3 では非推奨です。Red Hat ではこの機能の使用を推奨しておらず、Red Hat Gluster Storage 3.5.3 にアップグレードする新規デプロイメントおよび既存デプロイメントでサポートしません。

| はい | はい | はい | はい |

| RDMA(非推奨)

警告

RDMA をトランスポートプロトコルとして使用することは、Red Hat Gluster Storage 3.5 で非推奨となっています。Red Hat ではこの機能の使用を推奨しておらず、Red Hat Gluster Storage 3.5.3 にアップグレードする新規デプロイメントおよび既存デプロイメントでサポートしません。

| はい | いいえ | いいえ | いいえ |

| スナップショット | はい | はい | はい | はい |

| スナップショットのクローン作成 | はい | はい | はい | はい |

| スナップショットのマウント | はい | いいえ | いいえ | いいえ |

| 階層化 (Tiering)(非推奨)

警告

階層機能の使用は、Red Hat Gluster Storage 3.5 では非推奨です。Red Hat ではこの機能の使用を推奨しておらず、Red Hat Gluster Storage 3.5.3 にアップグレードする新規デプロイメントおよび既存デプロイメントでサポートしません。

| はい | はい | 該当なし | 該当なし |

1.7. Red Hat Gluster Storage のサポートマトリックス

| Red Hat Enterprise Linux のバージョン | Red Hat Gluster Storage のバージョン |

|---|---|

| 6.5 | 3.0 |

| 6.6 | 3.0.2、3.0.3、3.0.4 |

| 6.7 | 3.1、3.1.1、3.1.2 |

| 6.8 | 3.1.3 |

| 6.9 | 3.2 |

| 6.9 | 3.3 |

| 6.9 | 3.3.1 |

| 6.10 | 3.4、3.5 |

| 7.1 | 3.1、3.1.1 |

| 7.2 | 3.1.2 |

| 7.2 | 3.1.3 |

| 7.3 | 3.2 |

| 7.4 | 3.2 |

| 7.4 | 3.3 |

| 7.4 | 3.3.1 |

| 7.5 | 3.3.1、3.4 |

| 7.6 | 3.3.1、3.4 |

| 7.7 | 3.5、3.5.1 |

| 7.8 | 3.5.1、3.5.2 |

| 7.9 | 3.5.3, 3.5.4, 3.5.5, 3.5.6, 3.5.7 |

| 8.2 | 3.5.2、3.5.3 |

| 8.3 | 3.5.3 |

| 8.4 | 3.5.4 |

| 8.5 | 3.5.5, 3.5.6 |

| 8.6 | 3.5.7 |

第2章 Red Hat Gluster Storage のインストール

- テクノロジープレビューパッケージは、Red Hat Gluster Storage Server のこのインストールでもインストールされます。テクノロジープレビュー機能の一覧は、『 『Red Hat Gluster Storage 3.5 リリースノート』』 の「『テクノロジープレビュー』」の章を参照してください。

- Red Hat Gluster Storage Server がインストールされている仮想マシンのクローンを作成する場合には、クローンを作成する前に

/var/lib/glusterd/glusterd.infoファイル (ある場合) を削除する必要があります。このファイルを削除しないと、クローン作成されるマシンの UUID が同一になります。このファイルは、クローン作成された仮想マシン上の glusterd デーモンの初回起動時に UUID を使用して自動的に再作成されます。

2.1. Red Hat Gluster Storage の取得

2.1.1. Red Hat Gluster Storage Server for On-Premise の取得

- Red Hat カスタマーポータル (https://access.redhat.com/login) にアクセスし、ユーザー名およびパスワードを入力してログインします。

- Downloads をクリックし、 Software & Download Center に移動します。

- Red Hat Gluster Storage Server 領域で をクリックし、最新バージョンのソフトウェアをダウンロードします。

2.1.2. Red Hat Gluster Storage Server for Public Cloud の取得

2.2. ISO イメージからのインストール

2.2.1. Red Hat Enterprise Linux への Red Hat Gluster Storage 3.5 のインストール

- 「Red Hat Gluster Storage の取得」に説明されているように Red Hat Gluster Storage Server の ISO イメージファイルをダウンロードします。

- Welcome to Red Hat Gluster Storage 3.5 画面で、残りのインストールに使用する言語を選択し、Continue をクリックします。この選択内容が、後に変更しない限り、インストール済みシステムのデフォルトになります。注記1 つの言語が一覧の上部に事前に設定されます。この時点でネットワークアクセスが設定されている場合 (たとえば、ローカルメディアではなくネットワークサーバーから起動した場合など)、事前に選択した言語は、GeoIP モジュールの使用による場所の自動検出に基づいて決定されます。

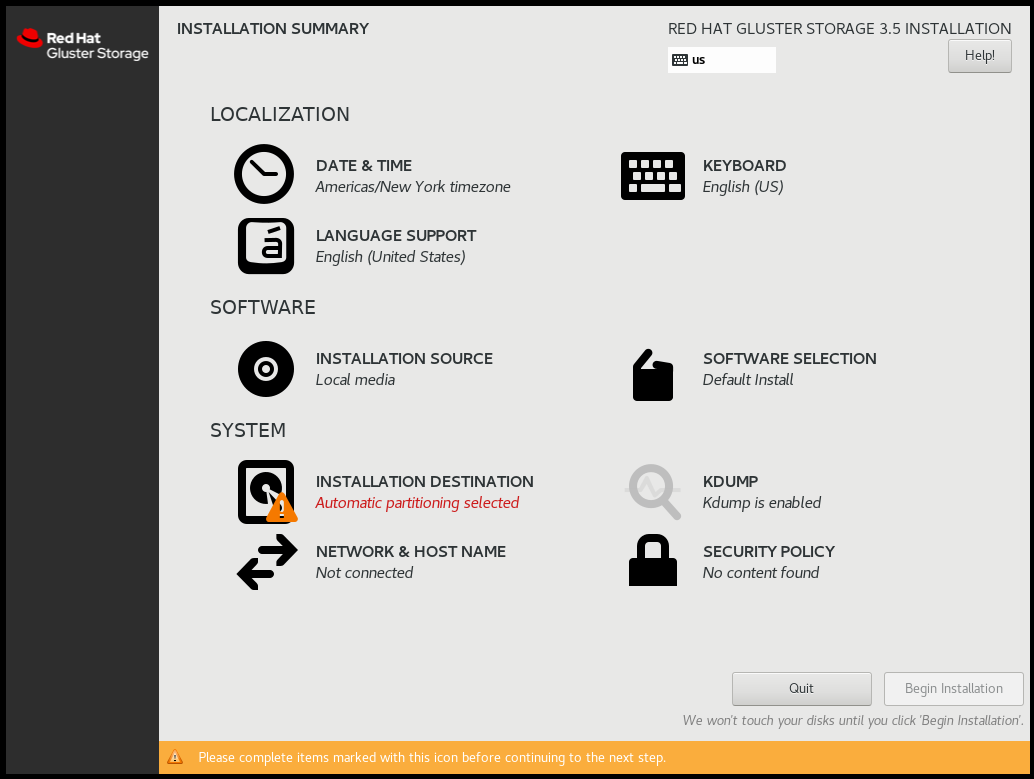

- Installation Summary 画面で、主なインストール設定を行います。

図2.1 Red Hat Gluster Storage 3.5 の Red Hat Enterprise Linux 8 へのインストールについての要約

図2.2 Red Hat Gluster Storage 3.5 の Red Hat Enterprise Linux 7 へのインストールについての要約

Red Hat Enterprise Linux 7.7 以降の Red Hat Gluster Storage 3.5 インストールプログは、最初から順番通りに画面を確認する方法ではなく、ユーザーが選択する順序でインストールを設定できます。インストールのセクションを設定するためにメニュー項目を選択します。セクションの設定が完了した後にそのセクションを後で完了することを希望する場合は、画面左上にある Done ボタンをクリックします。警告シンボルのマークが付いたセクションのみが必須です。画面の下部の注で警告されているように、これらをインストールを開始する前に選択する必要があります。残りのセクションはオプションです。各セクションのタイトルの下には、現在の設定の概要が示されます。これを使用して、追加で設定するセクションに移動する必要があるかどうかを判断できます。以下の一覧は、Installation Summary 画面の各メニュー項目の簡単な要約を示します。

Red Hat Enterprise Linux 7.7 以降の Red Hat Gluster Storage 3.5 インストールプログは、最初から順番通りに画面を確認する方法ではなく、ユーザーが選択する順序でインストールを設定できます。インストールのセクションを設定するためにメニュー項目を選択します。セクションの設定が完了した後にそのセクションを後で完了することを希望する場合は、画面左上にある Done ボタンをクリックします。警告シンボルのマークが付いたセクションのみが必須です。画面の下部の注で警告されているように、これらをインストールを開始する前に選択する必要があります。残りのセクションはオプションです。各セクションのタイトルの下には、現在の設定の概要が示されます。これを使用して、追加で設定するセクションに移動する必要があるかどうかを判断できます。以下の一覧は、Installation Summary 画面の各メニュー項目の簡単な要約を示します。日付と時間

- Date & Time をクリックし、システムクロックの精度を維持するためにタイムゾーンを指定します。

- Network Time スイッチを ON に切り替えます。注記デフォルトで、ネットワークに接続している場合は Network Time スイッチが有効になります。

- 設定アイコンをクリックして新しい NTP サーバーを追加するか、既存のサーバーを選択します。

- 追加または選択が完了したら、Done をクリックして Installation Summary 画面に戻ります。

注記NTP サーバーはインストール時に利用できない場合があります。この場合、これらを有効にしても時間は自動的に設定されません。サーバーが利用可能になると、日付と時刻が更新されます。言語サポート

追加のロケールおよび言語のサポートをインストールするには、Language Support を選択します。

キーボード設定

複数のキーボードレイアウトをシステムに追加するには、Keyboard を選択します。

インストールソース

Red Hat Enterprise Linux のインストール元となるファイルまたは場所を指定するには、Installation Source を選択します。この画面では、DVD や ISO ファイル、またはネットワークの場所など、ローカルで利用可能なインストールメディアを選択できます。

ネットワークおよびホスト名

システムに必要なネットワーク機能を設定するには、Network & Hostname を選択します。

重要Red Hat Enterprise Linux 7.7 以降での Red Hat Gluster Storage 3.5 で、インストールが完了し、システムが最初に起動する際に、インストール時に設定したネットワークインターフェースがアクティブになります。ただし、インストールでは、一部の一般的なインストールパスでネットワークインターフェースを設定するように求めるプロンプトは出されません。たとえば、DVD からローカルのハードドライブへの、Red Hat Gluster Storage 3.5 の Red Hat Enterprise Linux 7.5 へのインストールの場合などがこれに該当します。ローカルインストールソースからローカルストレージデバイスへの Red Hat Gluster Storage 3.5 の Red Hat Enterprise Linux 7.7 以降へのインストールを実行する場合、初回のシステムの起動時に、ネットワークアクセスが必要な場合に 1 つ以上のネットワークインターフェースを手動で設定するようにしてください。また、設定の編集時に、起動後自動的に接続する接続を設定する必要もあります。ソフトウェアの選択

インストールするパッケージを指定するには、Software Selection を選択します。以下のオプションのアドオンが必要な場合は、必要なアドオンを選択して Done をクリックします。

- RH-Gluster-AD-Integration

- RH-Gluster-NFS-Ganesha

- RH-Gluster-Samba-Server

インストール先

ディスクを選択し、Red Hat Gluster Storage をインストールするストレージ領域のパーティションを設定するには、Installation Destination を選択します。詳細は、Red Hat Enterprise Linux 7 インストールガイドの『Installation Destination』を参照してください。

Kdump

kdump は、カーネルクラッシュをダンプするメカニズムであり、システムクラッシュが発生時にクラッシュの原因を判別するのに極めて重要となる情報をキャプチャーします。このオプションは、システムで Kdump を使用するかどうかを選択する場合に使用します。

- 必要な設定を行ったら、インストール Installation Summary 画面で Begin Installation をクリックします。警告インストールプロセスのこの時点では、永続的な変更はコンピューターに加えられていません。Begin Installation をクリックすると、インストールプログラムはハードドライブの領域を割り当て、Red Hat Gluster Storage をこの領域に移動します。選択するパーティショニングオプションによっては、このプロセスにコンピューター上にすでに存在するデータの消去が含まれる場合があります。この時点までに行った選択のいずれかを変更するには、Installation Summary 画面の該当セクションに戻ります。インストールを完全に中止するには、Quit をクリックするか、コンピューターの電源を切ります。インストールのカスタマイズを終了し、インストールを続行する場合は、Begin Installation をクリックします。Begin Installation をクリックした後に、インストールプロセスを完了させます。たとえば、コンピューターの電源をオフにしたり、コンピューターをリセットしたり、電源異常が発生するなどでプロセスが中断された場合、Red Hat Gluster Storage のインストールプロセスを再開し、これを完了するまで、てコンピューターを使用できない可能性があります。

- Begin Installation をクリックすると、進捗画面が表示されます。Red Hat Gluster Storage では、選択したパッケージをシステムに書き込む際に画面にインストールの進捗が報告されます。以下は、この画面上のオプションの簡単な説明です。

root パスワード

Root Password メニュー項目は、root アカウントのパスワードを設定するために使用されます。root アカウントは、重要なシステム管理および管理タスクを実行するために使用されます。パスワードは、パッケージのインストール中またはその後に設定可能ですが、これが設定されるまでインストールプロセスを完了できません。

ユーザーの作成

ユーザーアカウントの作成はオプションであり、インストール後に実行できますが、この画面上で行うことが推奨されます。ユーザーアカウントは、通常の作業やシステムへのアクセスに使用されます。ベストプラクティスとして、root アカウントではなく、ユーザーアカウントを使用して常にシステムにアクセスすることが推奨されます。

- インストールが完了したら、Reboot をクリックしてシステムを再起動し、Red Hat Gluster Storage の使用を開始します。

2.3. Red Hat Gluster Storage Server チャンネルのサブスクライブ

Subscription Manager の使用

システムの Subscription Manager への登録

以下のコマンドを実行して、Red Hat Network のユーザー名およびパスワードを入力して、システムを Subscription Manager に登録します。subscription-manager register

# subscription-manager registerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 利用可能なエンタイトルメントプールの特定

以下のコマンドを実行して、Red Hat Gluster Storage のインストールに必要なリポジトリーが含まれるエンタイトルメントプールを見つけます。subscription-manager list --available | grep -A8 "Red Hat Enterprise Linux Server" subscription-manager list --available | grep -A8 "Red Hat Storage"

# subscription-manager list --available | grep -A8 "Red Hat Enterprise Linux Server" # subscription-manager list --available | grep -A8 "Red Hat Storage"Copy to Clipboard Copied! Toggle word wrap Toggle overflow システムへのエンタイトルメントプールのアタッチ

先の手順で特定したプール ID を使用して、Red Hat Enterprise Linux ServerおよびRed Hat Gluster Storageのエンタイトルメントをシステムにアタッチします。以下のコマンドを実行してエンタイトルメントをアタッチします。subscription-manager attach --pool=[POOLID]

# subscription-manager attach --pool=[POOLID]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下は例になります。subscription-manager attach --pool=8a85f9814999f69101499c05aa706e47

# subscription-manager attach --pool=8a85f9814999f69101499c05aa706e47Copy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux で Red Hat Gluster Storage に必要なチャンネルの有効化

Red Hat Enterprise Linux 6.7 以降での Red Hat Gluster Storage 3.5 の場合

- 以下のコマンドを実行して、Red Hat Gluster Storage のインストールに必要なリポジトリーを有効にします。

subscription-manager repos --enable=rhel-6-server-rpms subscription-manager repos --enable=rhel-scalefs-for-rhel-6-server-rpms subscription-manager repos --enable=rhs-3-for-rhel-6-server-rpms

# subscription-manager repos --enable=rhel-6-server-rpms # subscription-manager repos --enable=rhel-scalefs-for-rhel-6-server-rpms # subscription-manager repos --enable=rhs-3-for-rhel-6-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Samba が必要な場合は、以下のリポジトリーを有効にします。

subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-6-server-rpms

# subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-6-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - NFS-Ganesha は、Red Hat Enterprise Linux 6 ベースのインストールではサポートされません。

Red Hat Enterprise Linux 7.7 以降での Red Hat Gluster Storage 3.5 の場合

- 以下のコマンドを実行して、Red Hat Gluster Storage のインストールに必要なリポジトリーを有効にします。

subscription-manager repos --enable=rhel-7-server-rpms subscription-manager repos --enable=rh-gluster-3-for-rhel-7-server-rpms

# subscription-manager repos --enable=rhel-7-server-rpms # subscription-manager repos --enable=rh-gluster-3-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Samba が必要な場合は、以下のリポジトリーを有効にします。

subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-7-server-rpms

# subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Gluster Storage 3.5 の場合、NFS-Ganesha が必要な場合は、以下のリポジトリーを有効にします。

subscription-manager repos --enable=rh-gluster-3-nfs-for-rhel-7-server-rpms --enable=rhel-ha-for-rhel-7-server-rpms

# subscription-manager repos --enable=rh-gluster-3-nfs-for-rhel-7-server-rpms --enable=rhel-ha-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Gluster Storage 3.5 の場合は、CTDB が必要な場合は、以下のリポジトリーを有効にします。

subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-7-server-rpms

# subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Red Hat Enterprise Linux 8.2 以降での Red Hat Gluster Storage 3.5 の場合

- 以下のコマンドを実行して、Red Hat Gluster Storage のインストールに必要なリポジトリーを有効にします。

subscription-manager repos --enable=rhel-8-for-x86_64-baseos-rpms subscription-manager repos --enable=rhel-8-for-x86_64-appstream-rpms subscription-manager repos --enable=rh-gluster-3-for-rhel-8-x86_64-rpms

# subscription-manager repos --enable=rhel-8-for-x86_64-baseos-rpms # subscription-manager repos --enable=rhel-8-for-x86_64-appstream-rpms # subscription-manager repos --enable=rh-gluster-3-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Samba が必要な場合は、以下のリポジトリーを有効にします。

subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-8-x86_64-rpms

# subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Gluster Storage 3.5 の場合、NFS-Ganesha が必要な場合は、以下のリポジトリーを有効にします。

subscription-manager repos --enable=rh-gluster-3-nfs-for-rhel-8-x86_64-rpms --enable=rhel-8-for-x86_64-highavailability-rpms

# subscription-manager repos --enable=rh-gluster-3-nfs-for-rhel-8-x86_64-rpms --enable=rhel-8-for-x86_64-highavailability-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Gluster Storage 3.5 の場合は、CTDB が必要な場合は、以下のリポジトリーを有効にします。

subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-8-x86_64-rpms

# subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

チャンネルが有効であるかどうかの確認

以下のコマンドを実行して、チャンネルが有効であるかどうかを確認します。yum repolist

# yum repolistCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Red Hat Satellite Server の使用

Red Hat Satellite にアクセスするためのクライアントシステムの設定

Red Hat Satellite にアクセスできるようにクライアントシステムを設定します。『『Red Hat Satellite 5.6 Client Configuration Guide』』の「『Registering Clients with Red Hat Satellite Server』」のセクションを参照してください。Red Hat Satellite Server への登録

以下のコマンドを実行して、システムを Red Hat Satellite Server に登録します。rhn_register

# rhn_registerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 標準ベースチャンネルへの登録

選択したオペレーティングシステムのリリースページで、All available updatesを選択し、プロンプトに従って、システムを Red Hat Enterprise Linux 6 -rhel-6-server-rpmsの標準ベースチャンネルに登録します。Red Hat Enterprise Linux 7 の標準ベースチャンネルはrhel-7-server-rpmsです。Red Hat Enterprise Linux 8 の標準ベースチャンネルはrhel-8-for-x86_64-baseos-rpmsです。必要な Red Hat Gluster Storage Server チャンネルのサブスクライブ

Red Hat Enterprise Linux 6.7 以降での Red Hat Gluster Storage 3.5 の場合

- 以下のコマンドを実行して、必要な Red Hat Gluster Storage サーバーチャンネルにシステムをサブスクライブします。

rhn-channel --add \ --channel rhel-6-server-rpms \ --channel rhel-scalefs-for-rhel-6-server-rpms \ --channel rhs-3-for-rhel-6-server-rpms

# rhn-channel --add \ --channel rhel-6-server-rpms \ --channel rhel-scalefs-for-rhel-6-server-rpms \ --channel rhs-3-for-rhel-6-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Samba が必要な場合は、以下のコマンドを実行して必要なチャンネルを有効にします。

rhn-channel --add --channel rh-gluster-3-samba-for-rhel-6-server-rpms

# rhn-channel --add --channel rh-gluster-3-samba-for-rhel-6-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - NFS-Ganesha は、Red Hat Enterprise Linux 6 ベースのインストールではサポートされません。

Red Hat Enterprise Linux 7.7 以降での Red Hat Gluster Storage 3.5 の場合

- 以下のコマンドを実行して、システムを Red Hat Enterprise Linux 7 に必要な Red Hat Gluster Storage サーバーチャンネルにサブスクライブします。

rhn-channel --add \ --channel rhel-7-server-rpms \ --channel rh-gluster-3-for-rhel-7-server-rpms

# rhn-channel --add \ --channel rhel-7-server-rpms \ --channel rh-gluster-3-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Samba が必要な場合は、以下のコマンドを実行して必要なチャンネルを有効にします。

rhn-channel --add --channel rh-gluster-3-samba-for-rhel-7-server-rpms

# rhn-channel --add --channel rh-gluster-3-samba-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Gluster Storage 3.5 および NFS-Ganesha の場合は、以下のチャンネルを有効にします。

rhn-channel --add --channel rhel-x86_64-server-7-rh-gluster-3-nfs --channel rhel-x86_64-server-ha-7

# rhn-channel --add --channel rhel-x86_64-server-7-rh-gluster-3-nfs --channel rhel-x86_64-server-ha-7Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Gluster Storage 3.5 の場合は、CTDB が必要な場合は、以下のチャンネルを有効にします。

rhn-channel --add --channel rh-gluster-3-samba-for-rhel-7-server-rpms

# rhn-channel --add --channel rh-gluster-3-samba-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Red Hat Enterprise Linux 8.2 以降での Red Hat Gluster Storage 3.5 の場合

- 以下のコマンドを実行して、システムを Red Hat Enterprise Linux 8 に必要な Red Hat Gluster Storage サーバーチャンネルにサブスクライブします。

rhn-channel --add \ --channel rh-gluster-3-for-rhel-8-x86_64-rpms# rhn-channel --add \ --channel rh-gluster-3-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Samba が必要な場合は、以下のコマンドを実行して必要なチャンネルを有効にします。

rhn-channel --add --channel rh-gluster-3-samba-for-rhel-8-x86_64-rpms

# rhn-channel --add --channel rh-gluster-3-samba-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Gluster Storage 3.5 および NFS-Ganesha の場合は、以下のチャンネルを有効にします。

rhn-channel --add --channel rh-gluster-3-nfs-for-rhel-8-x86_64-rpms --channel rhel-8-for-x86_64-highavailability-rpms

# rhn-channel --add --channel rh-gluster-3-nfs-for-rhel-8-x86_64-rpms --channel rhel-8-for-x86_64-highavailability-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Gluster Storage 3.5 の場合は、CTDB が必要な場合は、以下のチャンネルを有効にします。

rhn-channel --add --channel rh-gluster-3-samba-for-rhel-8-x86_64-rpms

# rhn-channel --add --channel rh-gluster-3-samba-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

システムが正常に登録されたかどうかを確認します。

以下のコマンドを実行して、システムが正常に登録されていることを確認します。rhn-channel --list rhel-x86_64-server-7 rhel-x86_64-server-7-rh-gluster-3

# rhn-channel --list rhel-x86_64-server-7 rhel-x86_64-server-7-rh-gluster-3Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4. Red Hat Gluster Storage Server の Red Hat Enterprise Linux へのインストール (階層化インストール)

/var パーティション、geo-レプリケーション関連の各種ファイルおよびその他のファイルを作成することが推奨されます。

Red Hat Enterprise Linux Server のベースインストールの実行

Red Hat Gluster Storage は、Red Hat Enterprise Linux 7 (RHEL 7) および Red Hat Enterprise Linux 8 (RHEL 8) でサポートされています。最新の RHEL バージョンを選択することが強く推奨されます。重要Red Hat Gluster Storage は 3.5 Batch Update 1 以降では、Red Hat Enterprise Linux 6 (RHEL 6) でサポートされません。表1.3「バージョンの詳細」を参照してください。システムの Subscription Manager への登録

システムを subscription manager に登録する方法については、「Red Hat Gluster Storage Server チャンネルのサブスクライブ」 を参照してください。カーネルバージョンの要件

Red Hat Gluster Storage では、kernel-2.6.32-431.17.1.el6 バージョン以降をシステムで使用する必要があります。以下のコマンドを実行して、インストール済みの実行中のカーネルのバージョンを確認します。rpm -q kernel kernel-2.6.32-431.el6.x86_64 kernel-2.6.32-431.17.1.el6.x86_64

# rpm -q kernel kernel-2.6.32-431.el6.x86_64 kernel-2.6.32-431.17.1.el6.x86_64Copy to Clipboard Copied! Toggle word wrap Toggle overflow uname -r 2.6.32-431.17.1.el6.x86_64

# uname -r 2.6.32-431.17.1.el6.x86_64Copy to Clipboard Copied! Toggle word wrap Toggle overflow すべてのパッケージの更新

以下のコマンドを実行して、すべてのパッケージが最新の状態であることを確認します。yum update

# yum updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要いずれかのカーネルパッケージを更新した場合は、以下のコマンドを実行してシステムを再起動します。shutdown -r now

# shutdown -r nowCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Gluster Storage のインストール

以下のコマンドを実行して Red Hat Gluster Storage をインストールします。yum install redhat-storage-server

# yum install redhat-storage-serverCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Samba をインストールするには、3章Samba の Red Hat Gluster Storage へのデプロイを参照してください。

- NFS-Ganesha をインストールするには、4章NFS-Ganesha の Red Hat Gluster Storage への NFS-Ganesha へのデプロイを参照してください。

再起動

システムを再起動します。

2.5. PXE サーバーからのインストール

Network Boot または Boot Services のラベルを付けられる場合があります。PXE ブートを適切に設定すると、コンピューターは他のメディアなしで Red Hat Gluster Storage Server インストールシステムを起動できます。

- ネットワークケーブルが接続されていることを確認します。コンピューターの電源がオンになっていない場合でも、ネットワークソケットのリンクインジケーターのライトがオンになっているはずです。

- コンピューターの電源を入れます。

- メニュー画面が表示されます。優先オプションに対応する数字キーを押します。

2.6. Red Hat Satellite Server からのインストール

2.6.1. Red Hat Satellite Server 6.x の使用

- 新規マニフェストファイルを作成し、Satellite 6 サーバーにマニフェストをアップロードします。

- 必要な Red Hat Gluster Storage リポジトリーを検索し、それらを有効にします。

- Red Hat Gluster Storage について有効にされているすべてのリポジトリーを同期します。

- 新規のコンテンツビューを作成し、必要なすべての製品を追加します。

- コンテンツビューを公開し、アクティベーションキーを作成します。

- 必要なクライアントの登録

rpm -Uvh satellite-server-host-address/pub/katello-ca-consumer-latest.noarch.rpm subscription-manager register --org=”Organization_Name” --activationkey=”Activation_Key”

# rpm -Uvh satellite-server-host-address/pub/katello-ca-consumer-latest.noarch.rpm # subscription-manager register --org=”Organization_Name” --activationkey=”Activation_Key”Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 利用可能なエンタイトルメントプールの特定

subscription-manager list --available

# subscription-manager list --availableCopy to Clipboard Copied! Toggle word wrap Toggle overflow - システムへのエンタイトルメントプールのアタッチ

subscription-manager attach --pool=Pool_ID

# subscription-manager attach --pool=Pool_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 必要なチャンネルのサブスクライブ

- RHEL および Gluster チャンネルの有効化Red Hat Enterprise Linux 8 の場合

subscription-manager repos --enable=rhel-8-for-x86_64-baseos-rpms --enable=rhel-8-for-x86_64-appstream-rpms subscription-manager repos --enable=rh-gluster-3-for-rhel-8-x86_64-rpms

# subscription-manager repos --enable=rhel-8-for-x86_64-baseos-rpms --enable=rhel-8-for-x86_64-appstream-rpms # subscription-manager repos --enable=rh-gluster-3-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 7 の場合subscription-manager repos --enable=rhel-7-server-rpms --enable=rh-gluster-3-for-rhel-7-server-rpms

# subscription-manager repos --enable=rhel-7-server-rpms --enable=rh-gluster-3-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Samba が必要な場合は、そのリポジトリーを有効にします。Red Hat Enterprise Linux 8 の場合

subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-8-x86_64-rpms

# subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 7 の場合subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-7-server-rpms

# subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - NFS-Ganesha が必要な場合は、そのリポジトリーを有効にします。Red Hat Enterprise Linux 8 の場合

subscription-manager repos --enable=rh-gluster-3-nfs-for-rhel-8-x86_64-rpms

# subscription-manager repos --enable=rh-gluster-3-nfs-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 7 の場合subscription-manager repos --enable=rh-gluster-3-nfs-for-rhel-7-server-rpms

# subscription-manager repos --enable=rh-gluster-3-nfs-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - HA が必要な場合は、そのリポジトリーを有効にします。Red Hat Enterprise Linux 8 の場合

subscription-manager repos --enable=rhel-8-for-x86_64-highavailability-rpms

# subscription-manager repos --enable=rhel-8-for-x86_64-highavailability-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 7 の場合subscription-manager repos --enable=rhel-ha-for-rhel-7-server-rpms

# subscription-manager repos --enable=rhel-ha-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - gdeploy が必要な場合は、Ansible リポジトリーを有効にします。Red Hat Enterprise Linux 8 の場合

subscription-manager repos --enable=ansible-2-for-rhel-8-x86_64-rpms

# subscription-manager repos --enable=ansible-2-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 7 の場合subscription-manager repos --enable=rhel-7-server-ansible-2-rpms

# subscription-manager repos --enable=rhel-7-server-ansible-2-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- Red Hat Gluster Storage のインストール

yum install redhat-storage-server

# yum install redhat-storage-serverCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6.2. Red Hat Satellite Server 5.x の使用

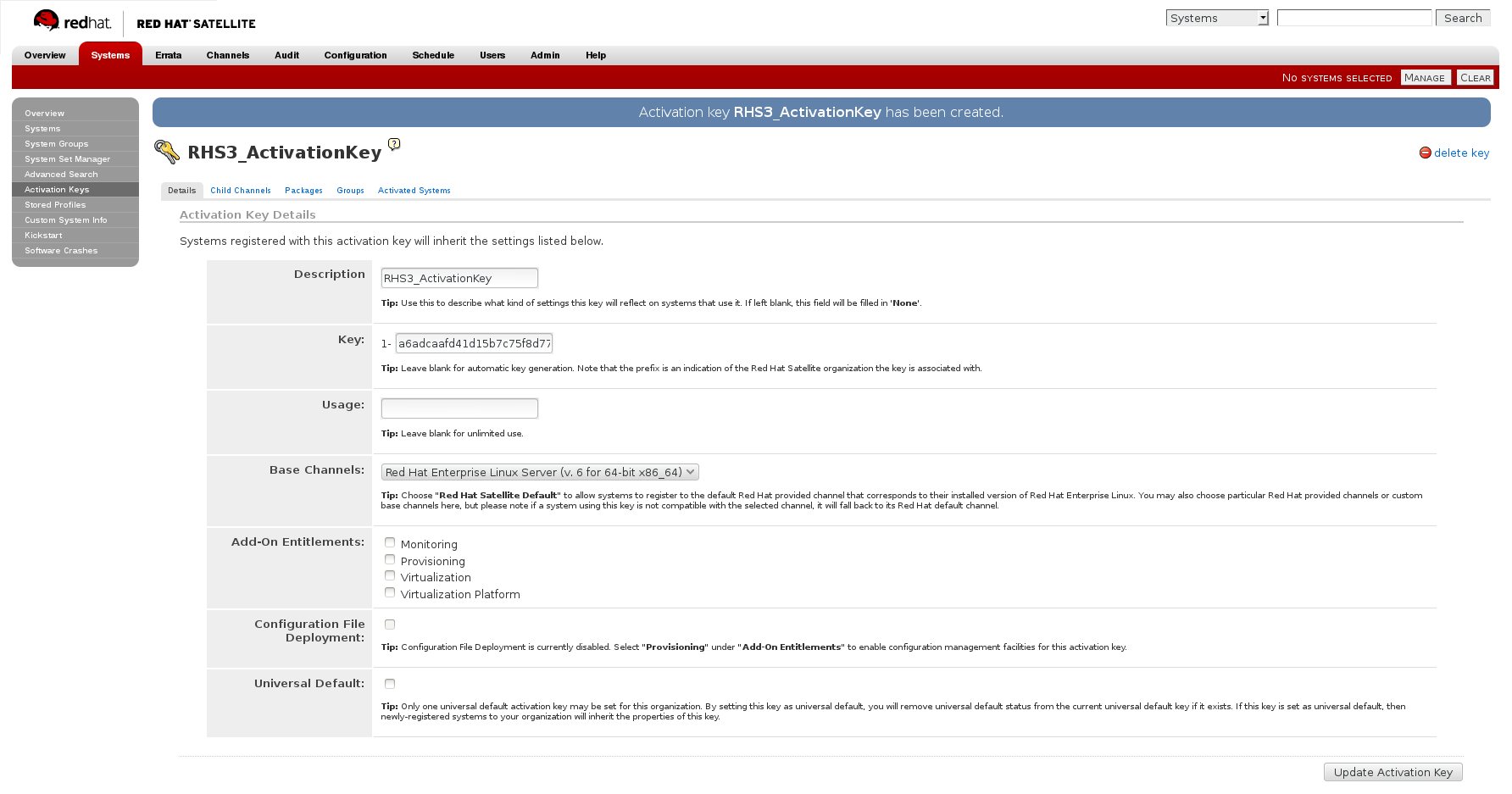

アクティベーションキーの作成

アクティベーションキーの作成方法についての詳細は、『『リファレンスガイド』』の「『アクティべーションキー』」を参照してください。

- Activation Keys 画面の Details タブで、Base Channels ドロップダウンリストから

Red Hat Enterprise Linux Server (v.6 for 64-bit x86_64)を選択します。図2.3 ベースチャンネル

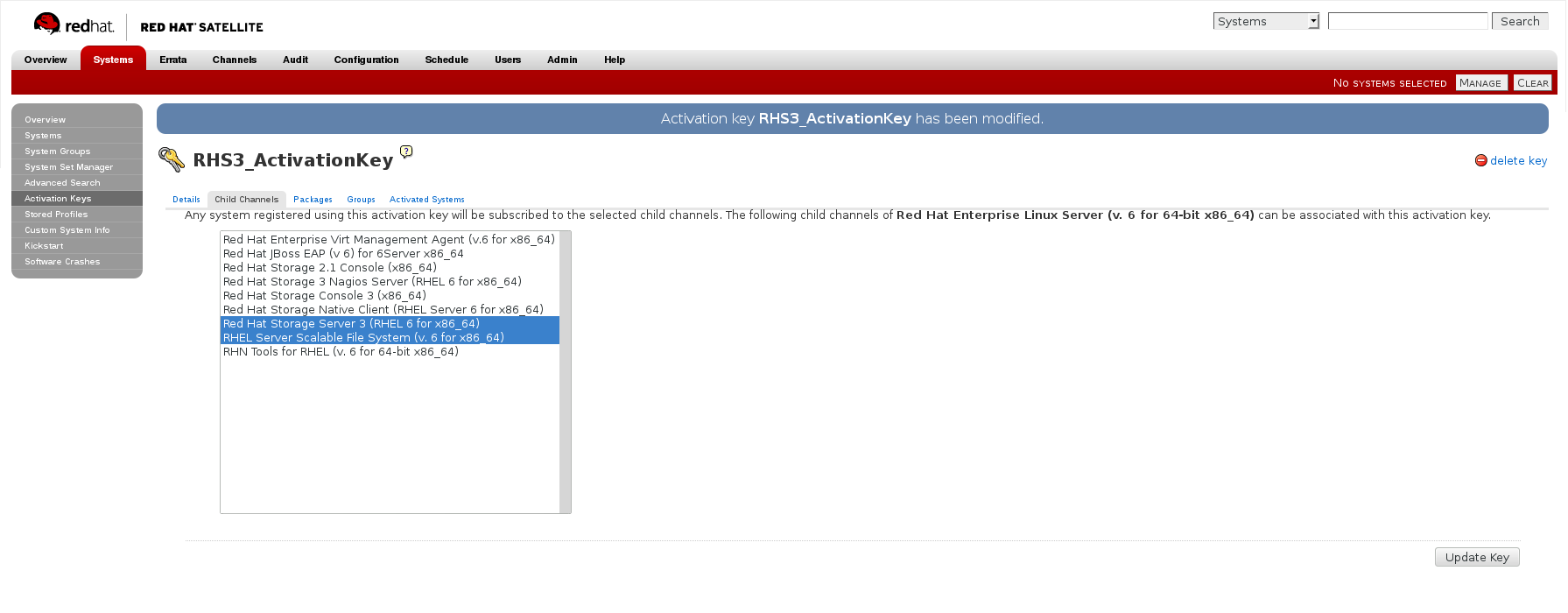

- Activation Keys 画面の Child Channels タブで、以下の子チャンネルを選択します。

RHEL Server Scalable File System (v. 6 for x86_64) Red Hat Gluster Storage Server 3 (RHEL 6 for x86_64)

RHEL Server Scalable File System (v. 6 for x86_64) Red Hat Gluster Storage Server 3 (RHEL 6 for x86_64)Copy to Clipboard Copied! Toggle word wrap Toggle overflow Samba パッケージが必要な場合は、以下の子チャンネルを選択します。Red Hat Gluster 3 Samba (RHEL 6 for x86_64)

Red Hat Gluster 3 Samba (RHEL 6 for x86_64)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 図2.4 子チャンネル

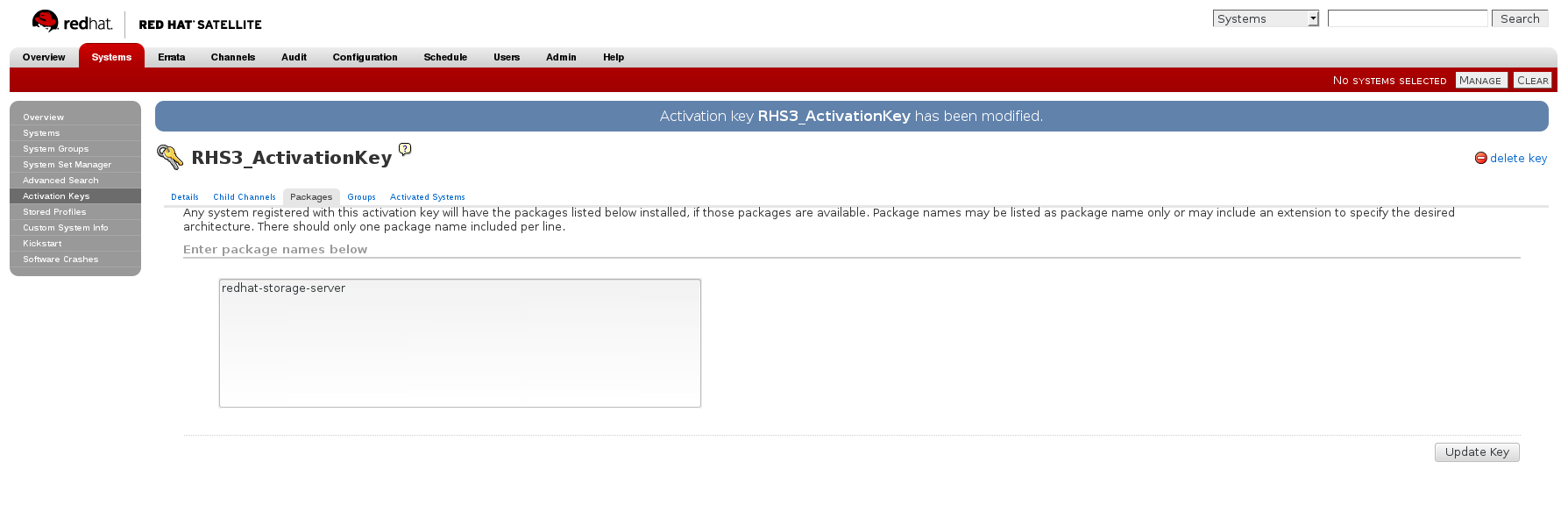

- Activation Keys 画面の Packages タブで、以下のパッケージ名を入力します。

redhat-storage-server

redhat-storage-serverCopy to Clipboard Copied! Toggle word wrap Toggle overflow 図2.5 パッケージ

- Samba パッケージが必要な場合は、以下のパッケージ名を入力します。

samba

sambaCopy to Clipboard Copied! Toggle word wrap Toggle overflow

キックスタートプロファイルの作成

キックスタートプロファイルの作成についての詳細は、『『リファレンスガイド』』の「『キックスタート』」を参照してください。

- キックスタートプロファイルを作成する場合は、以下の

Base ChannelおよびTreeを選択する必要があります。Base Channel: Red Hat Enterprise Linux Server(64 ビット x86_64 の場合は v.6)Tree: ks-rhel-x86_64-server-6-6.5 - 子チャンネルはキックスタートプロファイルに関連付けないでください。

- 以前に作成したアクティベーションキーをキックスタートプロファイルに関連付けます。

- デフォルトで、キックスタートプロファイルは、ユーザーパスワードのハッシュアルゴリズムとして

md5を選択します。キックスタートプロファイルのKickstart Details、Advanced Optionsページのauthフィールドに以下の設定を指定し、このアルゴリズムをsha512に変更する必要があります。--enableshadow --passalgo=sha512

--enableshadow --passalgo=sha512Copy to Clipboard Copied! Toggle word wrap Toggle overflow - キックスタートプロファイルを作成したら、キックスタートプロファイルの Kickstart Details、Advanced Options ページで root パスワードを変更し、準備済みの sha512 ハッシュアルゴリズムに基づいて root パスワードを追加する必要があります。

キックスタートプロファイルを使用した Red Hat Gluster Storage Server のインストール

キックスタートプロファイルを使用して Red Hat Gluster Storage Server をインストールする方法についての詳細は、『 『リファレンスガイド』』の「 『キックスタート』」を参照してください。

2.7. glusterd サービスの管理

glusterd サービスは、信頼できるストレージプールのすべてのサーバーで自動的に起動します。このサービスは、glusterd サービスのコマンドを使用して手動で起動および停止できます。信頼できるストレージプールの作成に関する詳細は、『『Red Hat Gluster Storage 3.5 Administration Guide』』を参照してください。

glusterd は柔軟性のあるボリューム管理を行います。

2.7.1. glusterd の手動による起動および停止

glusterd サービスを手動で起動し、停止します。

- 以下のように glusterd を手動で起動します。

/etc/init.d/glusterd start

# /etc/init.d/glusterd startCopy to Clipboard Copied! Toggle word wrap Toggle overflow またはservice glusterd start

# service glusterd startCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 以下のように glusterd を手動で停止します。

/etc/init.d/glusterd stop

# /etc/init.d/glusterd stopCopy to Clipboard Copied! Toggle word wrap Toggle overflow またはservice glusterd stop

# service glusterd stopCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.8. Gdeploy をサポートする Ansible のインストール

- 以下のコマンドを実行して、Ansible のインストールに必要なリポジトリーを有効にします。Red Hat Enterprise Linux 8 の場合

subscription-manager repos --enable=ansible-2-for-rhel-8-x86_64-rpms

# subscription-manager repos --enable=ansible-2-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 7 の場合subscription-manager repos --enable=rhel-7-server-ansible-2-rpms

# subscription-manager repos --enable=rhel-7-server-ansible-2-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 以下のコマンドを実行して、

ansibleをインストールします。yum install ansible

# yum install ansibleCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.9. ネイティブクライアントのインストール

- Red Hat Gluster Storage サーバーは、サーバーバージョンとネイティブクライアントの以前のバージョンと同じネイティブクライアントのバージョンをサポートします。リリースの一覧は、https://access.redhat.com/solutions/543123 を参照してください。

- Red Hat Gluster Storage 3.5 バッチ更新 7 以降、

glusterfs-6.0-62以降のバージョンの glusterFS ネイティブクライアントを使用するには、Red Hat Enterprise Enterprise Linux (RHEL 8) をベースとする Red Hat Gluster Storage ではrh-gluster-3-client-for-rhel-8-x86_64-rpms、RHEL 7 をベースとする Red Hat Gluster Storage ではrh-gluster-3-client-for-rhel-7-server-rpmsを必ず経由する必要があります。

コマンドラインを使用した、システムの Red Hat Subscription Management への登録およびサブスクライブ

前提条件

- Red Hat Gluster Storage エンタイトルメントのある Red Hat Subscription Manager アカウントのユーザー名およびパスワードを把握します。

- subscription-manager register コマンドを実行して、利用可能なプールを一覧表示します。適切なプールを選択し、Red Hat Subscription Manager のユーザー名とパスワードを入力して、システムを Red Hat Subscription Manager に登録します。

subscription-manager register

# subscription-manager registerCopy to Clipboard Copied! Toggle word wrap Toggle overflow - クライアントに応じて、以下のコマンドのいずれかを実行して正しいリポジトリーにサブスクライブします。

- Red Hat Enterprise Linux 8 クライアントの場合:

subscription-manager repos --enable=rh-gluster-3-client-for-rhel-8-x86_64-rpms

# subscription-manager repos --enable=rh-gluster-3-client-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Enterprise Linux 7.x クライアントの場合:

subscription-manager repos --enable=rhel-7-server-rpms --enable=rh-gluster-3-client-for-rhel-7-server-rpms

# subscription-manager repos --enable=rhel-7-server-rpms --enable=rh-gluster-3-client-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記以下のコマンドも使用できますが、Red Hat Gluster Storage では今後のリリースでこのリポジトリーのサポートが非推奨になる可能性があります。subscription-manager repos --enable=rhel-7-server-rh-common-rpms

# subscription-manager repos --enable=rhel-7-server-rh-common-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Enterprise Linux 6.1 以降のクライアントの場合:

subscription-manager repos --enable=rhel-6-server-rpms --enable=rhel-6-server-rhs-client-1-rpms

# subscription-manager repos --enable=rhel-6-server-rpms --enable=rhel-6-server-rhs-client-1-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

詳細は、「『Using and Configuring Red Hat Subscription Management』」の「Section 3.1 Registering and attaching a system using the Command Line」を参照してください。 - システムが、必要なリポジトリーにサブスクライブされていることを確認します。

yum repolist

# yum repolistCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Web インターフェースを使用したシステム登録およびサブスクライブ

前提条件

- Red Hat Gluster Storage エンタイトルメントのある Red Hat Subsrciption Management (RHSM) アカウントのユーザー名およびパスワードを把握します。

- Red Hat Subscription Management (https://access.redhat.com/management) にログオンします。

- 画面上部の Systems リンクをクリックします。

- Red Hat Gluster Storage Native Client チャンネルを追加する必要のあるシステムの名前をクリックします。

- 画面の Subscribed Channels セクションで をクリックします。

- クライアントプラットフォームに応じて、

Red Hat Enterprise Linux 8 for x86_64、Red Hat Enterprise Linux 7 for x86_64、Red Hat Enterprise Linux 6 for x86_64、またはRed Hat Enterprise Linux 5 for x86_64のノードを展開します。 - ボタンをクリックし、変更を確定します。ページの更新時に Details タブを選択して、システムが適切なチャンネルにサブスクライブされていることを確認します。

ネイティブクライアントパッケージのインストール

前提条件

- yum install コマンドを実行して、ネイティブクライアントの RPM パッケージをインストールします。

yum install glusterfs glusterfs-fuse

# yum install glusterfs glusterfs-fuseCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第3章 Samba の Red Hat Gluster Storage へのデプロイ

3.1. 前提条件

- Red Hat Gluster Storage Server をターゲットサーバーにインストールする必要があります。警告

- Red Hat Gluster Storage の階層化インストールの場合、Red Hat Enterprise Linux から Samba または CTDB パッケージがインストールされていない状態で、デフォルトの Red Hat Enterprise Linux サーバーインストールのみがあることを確認します。

- Samba バージョン 3 は、Red Hat Gluster Storage 3.0 Update 4 で非推奨にされていいます。samba-3.x では、それ以降の更新は提供されません。セキュリティー更新を含むすべての更新について、別のチャンネルまたはリポジトリーで提供される Samba-4.x にアップグレードすることが推奨されます。

- CTDB バージョン 2.5 は、Red Hat Gluster Storage 3.1 Update 2 ではサポートされていません。Red Hat Gluster Storage 3.1.2 以降で CTDB を使用するには、システムを Red Hat Gluster Storage の Samba チャンネルで提供される CTDB 4.x にアップグレードする必要があります。

- Samba 4.x から Samba 3.x への Samba のダウングレードはサポートされていません。

- 同じクラスターで異なるバージョンの Samba を実行するとデータが破損するため、Samba がすべてのノードで同時にアップグレードされることを確認します。

- Samba パッケージが利用可能なチャンネルを有効にします。

Red Hat Enterprise Linux 6.x での Red Hat Gluster Storage 3.5 の場合

- Red Hat Subscription Manager または Satellite server-6.x を使用してマシンを登録した場合は、以下のコマンドを実行してリポジトリーを有効にします。

subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-6-server-rpms

# subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-6-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Red Hat Enterprise Linux 7.7 以降での Red Hat Gluster Storage 3.5 の場合

- Red Hat Subscription Manager または Satellite server-7.x を使用してマシンを登録した場合は、以下のコマンドを実行してリポジトリーを有効にします。

subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-7-server-rpms

# subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Red Hat Enterprise Linux 8.2 以降での Red Hat Gluster Storage 3.5 の場合

- Red Hat Subscription Manager または Satellite server-8.x を使用してマシンを登録した場合は、以下のコマンドを実行してリポジトリーを有効にします。

subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-8-x86_64-rpms

# subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.2. ISO を使用した Samba のインストール

図3.1 パッケージのカスタマイズ

3.3. yum を使用した Samba のインストール

yum groupinstall RH-Gluster-Samba-Server

# yum groupinstall RH-Gluster-Samba-Serveryum groupinstall RH-Gluster-AD-Integration

# yum groupinstall RH-Gluster-AD-IntegrationSamba は、以下の手順に従ってインストールすることもできます。

- 基本的な Samba パッケージをインストールするには、以下のコマンドを実行します。

yum install samba

# yum install sambaCopy to Clipboard Copied! Toggle word wrap Toggle overflow smbclientをサーバーで必要とする場合は、以下のコマンドを実行します。yum install samba-client

# yum install samba-clientCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Active ディレクトリーの設定が必要な場合は、以下のコマンドを実行します。

yum install samba-winbind yum install samba-winbind-clients yum install samba-winbind-krb5-locator

# yum install samba-winbind # yum install samba-winbind-clients # yum install samba-winbind-krb5-locatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 以下のパッケージがインストールされているかどうかを確認します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第4章 NFS-Ganesha の Red Hat Gluster Storage への NFS-Ganesha へのデプロイ

- yum を使用した NFS-Ganesha のインストール

- ISO インストール時の NFS-Ganesha のインストール

4.1. 前提条件

Red Hat Enterprise Linux 8.2 以降での Red Hat Gluster Storage 3.5 の場合

NFS-Ganesha パッケージが利用可能なチャンネルを有効にします。

- Red Hat Subscription Manager を使用してマシンを登録した場合は、以下のコマンドを実行してリポジトリーを有効にします。

subscription-manager repos --enable=rh-gluster-3-nfs-for-rhel-8-x86_64-rpms

# subscription-manager repos --enable=rh-gluster-3-nfs-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow HA リポジトリーを追加するには、以下のコマンドを実行します。subscription-manager repos --enable=rhel-8-for-x86_64-highavailability-rpms

# subscription-manager repos --enable=rhel-8-for-x86_64-highavailability-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Satellite サーバーを使用してマシンを登録している場合は、以下のコマンドを実行してチャンネルを有効にします。

rhn-channel --add --channel rh-gluster-3-nfs-for-rhel-8-x86_64-rpms

# rhn-channel --add --channel rh-gluster-3-nfs-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow HA チャンネルにサブスクライブするには、以下のコマンドを実行します。rhn-channel --add --channel rhel-8-for-x86_64-highavailability-rpms

# rhn-channel --add --channel rhel-8-for-x86_64-highavailability-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Red Hat Enterprise Linux 7.7 以降での Red Hat Gluster Storage 3.5 の場合

NFS-Ganesha パッケージが利用可能なチャンネルを有効にします。

- Red Hat Subscription Manager を使用してマシンを登録した場合は、以下のコマンドを実行してリポジトリーを有効にします。

subscription-manager repos --enable=rh-gluster-3-nfs-for-rhel-7-server-rpms

# subscription-manager repos --enable=rh-gluster-3-nfs-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow HA リポジトリーを追加するには、以下のコマンドを実行します。subscription-manager repos --enable=rhel-ha-for-rhel-7-server-rpms

# subscription-manager repos --enable=rhel-ha-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Satellite サーバーを使用してマシンを登録している場合は、以下のコマンドを実行してチャンネルを有効にします。

rhn-channel --add --channel rhel-x86_64-server-7-rh-gluster-3-nfs

# rhn-channel --add --channel rhel-x86_64-server-7-rh-gluster-3-nfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow HA チャンネルにサブスクライブするには、以下のコマンドを実行します。rhn-channel --add --channel rhel-x86_64-server-ha-7

# rhn-channel --add --channel rhel-x86_64-server-ha-7Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2. ISO インストール時の NFS-Ganesha のインストール

- ISO を使用して Red Hat Storage をインストールする場合は、Customizing the Software Selection 画面で RH-Gluster-NFS-Ganesha を選択し、Next をクリックします。

- Red Hat Gluster Storage のインストールの残りのインストール手順に進んでください。ISO を使用して Red Hat Storage をインストールする方法についての詳細は、「ISO イメージからのインストール」を参照してください。

4.3. yum を使用した NFS-Ganesha のインストール

- 以下のコマンドを使用して、glusterfs-ganesha パッケージをインストールできます。

yum install glusterfs-ganesha

# yum install glusterfs-ganeshaCopy to Clipboard Copied! Toggle word wrap Toggle overflow NFS-Ganesha は上記のパッケージと共にインストールされます。nfs-ganesha-gluster および HA パッケージもインストールされます。重要以下のコマンドを実行して、Red Hat Enterprise Linux 7 に nfs-ganesha-selinux をインストールします。yum install nfs-ganesha-selinux

# yum install nfs-ganesha-selinuxCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、Red Hat Enterprise Linux 8 に nfs-ganesha-selinux をインストールします。dnf install glusterfs-ganesha

# dnf install glusterfs-ganeshaCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第5章 Red Hat Gluster Storage 3.5 へのアップグレード

アップグレードサポートの制限

- RHGS を RHGS-3.5.4 より低いバージョンから RHGS-3.5.4 以降にアップグレードする場合は、サーバーとクライアントの両方を RHGS-3.5.4 以降のバージョンにアップグレードしてから、クラスターの動作バージョンを増やす必要があります。

- Red Hat Enterprise Linux 7.5 でサポートされる Virtual Data Optimizer (VDO) ボリュームは、現時点では Red Hat Gluster Storage でサポートされていません。VDO は、Red Hat Hyperconverged Infrastructure for Virtualization 2.0 の一部として使用されている場合にのみサポートされます。詳細は、 VDO について参照してください。

- クライアントをアップグレードする前に、サーバーをアップグレードする必要があります。

- Red Hat Gluster Storage 3.1 Update 2 以前からアップグレードする場合は、サーバーとクライアントを同時にアップグレードする必要があります。

- NFS-Ganesha を使用する場合、Red Hat Gluster Storage 3.5 へのサポートされるアップグレードパスは、アップグレードするバージョンによって異なります。バージョン 3.3 以前のバージョンからアップグレードする場合は、『Red Hat Gluster Storage 3.3 へのおふぃラインアップグレード』を実行してから、バージョン 3.3 から 3.4 へのインサービスアップグレードを実行します。後で、「Red Hat Gluster Storage 3.4 から Red Hat Gluster Storage 3.5 へのインサービスソフトウェアアップグレード」 を使用してバージョン 3.4 から 3.5 にアップグレードします。バージョン 3.4 から 3.5 にアップグレードする場合、「Red Hat Gluster Storage 3.4 から Red Hat Gluster Storage 3.5 へのインサービスソフトウェアアップグレード」 を直接使用します。

5.1. Red Hat Gluster Storage 3.5 へのオフラインアップグレード

5.1.1. Red Hat Subscription Manager にサブスクライブしているシステム向けの Red Hat Gluster Storage 3.5 へのアップグレード

手順5.1 アップグレード前

- オペレーティングシステムパーティション上ではない場所に、設定ディレクトリーとファイルをバックアップします。

/var/lib/glusterd/etc/samba/etc/ctdb/etc/glusterfs/var/lib/samba/var/lib/ctdb/var/run/gluster/shared_storage/nfs-ganesha

注記3.5 Batch Update 3 のリリースにより、共有ストレージのマウントポイントが /var/run/gluster/ から /run/gluster/ に変更されました。NFS-Ganesha を使用する場合は、すべてのノードから以下のファイルをバックアップします。/run/gluster/shared_storage/nfs-ganesha/exports/export.*.conf/etc/ganesha/ganesha.conf/etc/ganesha/ganesha-ha.conf

Red Hat Gluster Storage 3.3 から 3.4 以降のリリースにアップグレードする場合は、すべてのノードのブリックの root で以下のコマンドを個別に実行し、すべての xattr をバックアップします。find ./ -type d ! -path "./.*" ! -path "./" | xargs getfattr -d -m. -e hex > /var/log/glusterfs/xattr_dump_brick_name

# find ./ -type d ! -path "./.*" ! -path "./" | xargs getfattr -d -m. -e hex > /var/log/glusterfs/xattr_dump_brick_nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow - すべてのクライアントから gluster ボリュームをアンマウントします。クライアントで以下のコマンドを使用して、マウントポイントからボリュームをアンマウントします。

umount mount-point

# umount mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow - NFS-Ganesha を使用する場合は、gluster サーバーで以下のコマンドを実行して nfs-ganesha サービスを無効にします。

gluster nfs-ganesha disable

# gluster nfs-ganesha disableCopy to Clipboard Copied! Toggle word wrap Toggle overflow - gluster サーバーで、共有ボリュームを無効にします。

gluster volume set all cluster.enable-shared-storage disable

# gluster volume set all cluster.enable-shared-storage disableCopy to Clipboard Copied! Toggle word wrap Toggle overflow - すべてのボリュームを停止

for vol in `gluster volume list`; do gluster --mode=script volume stop $vol; sleep 2s; done

# for vol in `gluster volume list`; do gluster --mode=script volume stop $vol; sleep 2s; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow - すべてのボリュームが停止していることを確認します。

gluster volume info

# gluster volume infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 以下のコマンドを使用して、すべてのサーバーで

glusterdサービスを停止します。service glusterd stop pkill glusterfs pkill glusterfsd

# service glusterd stop # pkill glusterfs # pkill glusterfsdCopy to Clipboard Copied! Toggle word wrap Toggle overflow - pcsd サービスを停止します。

systemctl stop pcsd

# systemctl stop pcsdCopy to Clipboard Copied! Toggle word wrap Toggle overflow

手順5.2 yum を使用したアップグレード

migrate-rhs-classic-to-rhsm --status

# migrate-rhs-classic-to-rhsm --statusmigrate-rhs-classic-to-rhsm --rhn-to-rhsm

# migrate-rhs-classic-to-rhsm --rhn-to-rhsmmigrate-rhs-classic-to-rhsm --status

# migrate-rhs-classic-to-rhsm --status- Samba を使用する場合:

- Red Hat Enterprise Linux 6.7 以降では、以下のリポジトリーを有効にします。

subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-6-server-rpms

# subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-6-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 7 の場合は、以下のリポジトリーを有効にします。subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-7-server-rpms

# subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 8 の場合は、以下のリポジトリーを有効にします。subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-8-x86_64-rpms

# subscription-manager repos --enable=rh-gluster-3-samba-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 同じクラスターで異なるバージョンの Samba を実行するとデータが破損するため、Samba がすべてのノードで同時にアップグレードされることを確認します。CTDB サービスおよび SMB サービスを停止します。Red Hat Enterprise Linux 7 および Red Hat Enterprise Linux 8 の場合:

systemctl stop ctdb

# systemctl stop ctdbCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 6 の場合:service ctdb stop

# service ctdb stopCopy to Clipboard Copied! Toggle word wrap Toggle overflow サービスが停止していることを確認するには、以下を実行します。ps axf | grep -E '(ctdb|smb|winbind|nmb)[d]'

# ps axf | grep -E '(ctdb|smb|winbind|nmb)[d]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- サーバーを Red Hat Gluster Storage 3.5 にアップグレードします。

yum update

# yum updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow 更新が完了するまで待ちます。重要以下のコマンドを実行して、Red Hat Enterprise Linux 7 に nfs-ganesha-selinux をインストールします。yum install nfs-ganesha-selinux

# yum install nfs-ganesha-selinuxCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、Red Hat Enterprise Linux 8 に nfs-ganesha-selinux をインストールします。dnf install glusterfs-ganesha

# dnf install glusterfs-ganeshaCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Samba/CTDB を使用する場合は、以下のファイルを更新して、

META="all"をMETA="<ctdb_volume_name>"に置き換えます (例:META="ctdb")。/var/lib/glusterd/hooks/1/start/post/S29CTDBsetup.sh: このスクリプトは、ファイルシステムおよびそのロックボリュームが、Samba を使用するすべての Red Hat Gluster Storage サーバーにマウントされ、CTDB がシステムの起動時に起動するようにします。/var/lib/glusterd/hooks/1/stop/pre/S29CTDB-teardown.sh: このスクリプトは、ファイルシステムおよびそのロックボリュームが、CTDB ボリュームが停止する場合にアンマウントされるようにします。注記RHEL ベースの Red Hat Gluster Storage が Samba で 3.5 バッチ更新 4 にアップグレードするには、既存のすべての samba ボリュームに対して、write-behind トランスレーターを手動で無効にする必要があります。gluster volume set <volname> performance.write-behind off

# gluster volume set <volname> performance.write-behind offCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- サーバーを再起動して、カーネルの更新が適用されるようにします。

- glusterd サービスおよび pcsd サービスが起動していることを確認します。

systemctl start glusterd systemctl start pcsd

# systemctl start glusterd # systemctl start pcsdCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記サーバーのアップグレード時に、glustershd.log ファイルは、アップグレードされたノードですべてのインデックスクロール(10 分)時に「Invalid argument」エラーが出力されます。これは「予期されており」であり、op-version が増えるまで「無視」することができます。その後、これらのエラーはトリガーされません。エラーメッセージの例:op-version が '70000' 未満の場合は、すべてのサーバーとクライアントが新しいバージョンにアップグレードするまで、op-version を「70100」以上に増やしません。[2021-05-25 17:58:38.007134] E [MSGID: 114031] [client-rpc-fops_v2.c:216:client4_0_mkdir_cbk] 0-spvol-client-40: remote operation failed. Path: (null) [Invalid argument]

[2021-05-25 17:58:38.007134] E [MSGID: 114031] [client-rpc-fops_v2.c:216:client4_0_mkdir_cbk] 0-spvol-client-40: remote operation failed. Path: (null) [Invalid argument]Copy to Clipboard Copied! Toggle word wrap Toggle overflow - すべてのノードがアップグレードされたら、以下のコマンドを実行してクラスターの

op-versionを更新します。これにより、クラスター内の互換性の問題を防ぐことができます。gluster volume set all cluster.op-version 70200

# gluster volume set all cluster.op-version 70200Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記70200は、Red Hat Gluster Storage 3.5 のcluster.op-version値です。Ater は cluster-op バージョンをアップグレードするため、指定したコマンドを使用してボリュームの詳細なエントリー修復を有効にします。この機能は、Red Hat Gluster Storage 3.5 へのアップグレード後にデフォルトで有効になりましたが、op-version を増やした後にのみ有効になります。他のバージョンの正しいgluster volume heal $VOLNAME granular-entry-heal enable

gluster volume heal $VOLNAME granular-entry-heal enableCopy to Clipboard Copied! Toggle word wrap Toggle overflow cluster.op-version値については、「Red Hat Gluster Storage のソフトウェアコンポーネントおよびバージョン」 を参照してください。重要サーバーをアップグレードしてクライアントをアップグレードする前にop-versionが「70100」に増えると、'.glusterfs-anonymous-inode-(gfid)' という名前のマウントポイントのルートの下にあるいくつかの内部メタデータファイルが古いものに公開されます。クライアントは I/O を実行できたり、このディレクトリーの内容を削除したり、変更したりしないでください。クライアントは 3.5.4 以降のバージョンにアップグレードする必要があり、このディレクトリーがクライアントに表示されるようになります。 - このアップグレードの一環として Gluster NFS から NFS Ganesha に移行する場合は、 4章NFS-Ganesha の Red Hat Gluster Storage への NFS-Ganesha へのデプロイの説明に従って NFS-Ganesha パッケージをインストールし、『『Red Hat Gluster Storage 3.5 Administration Guide』』の「NFS Ganesha」セクションの情報を参照して NFS Ganesha クラスターを設定します。

- すべてのボリュームを起動します。

for vol in `gluster volume list`; do gluster --mode=script volume start $vol; sleep 2s; done

# for vol in `gluster volume list`; do gluster --mode=script volume start $vol; sleep 2s; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow - NFS-Ganesha を使用している場合:

- ボリュームのエクスポート情報を

ganesha.confのバックアップコピーから、新しい/etc/ganesha/ganesha.confファイルにコピーします。バックアップファイルのエクスポート情報は、以下のようになります。%include "/var/run/gluster/shared_storage/nfs-ganesha/exports/export.v1.conf" %include "/var/run/gluster/shared_storage/nfs-ganesha/exports/export.v2.conf" %include "/var/run/gluster/shared_storage/nfs-ganesha/exports/export.v3.conf"

%include "/var/run/gluster/shared_storage/nfs-ganesha/exports/export.v1.conf" %include "/var/run/gluster/shared_storage/nfs-ganesha/exports/export.v2.conf" %include "/var/run/gluster/shared_storage/nfs-ganesha/exports/export.v3.conf"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記3.5 Batch Update 3 のリリースにより、共有ストレージのマウントポイントが /var/run/gluster/ から /run/gluster/ に変更されました。 - バックアップディレクトリーから以下のコマンドを実行し、バックアップボリュームのエクスポートファイルをバックアップディレクトリーから

/etc/ganesha/exportsにコピーします。cp export.* /etc/ganesha/exports/

# cp export.* /etc/ganesha/exports/Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- 共有ボリュームを有効にします。

gluster volume set all cluster.enable-shared-storage enable

# gluster volume set all cluster.enable-shared-storage enableCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 共有ストレージボリュームがサーバーにマウントされていることを確認します。ボリュームがマウントされていない場合は、以下のコマンドを実行します。

mount -t glusterfs hostname:gluster_shared_storage /var/run/gluster/shared_storage

# mount -t glusterfs hostname:gluster_shared_storage /var/run/gluster/shared_storageCopy to Clipboard Copied! Toggle word wrap Toggle overflow /var/run/gluster/shared_storage/nfs-ganeshaディレクトリーが作成されていることを確認します。cd /var/run/gluster/shared_storage/ mkdir nfs-ganesha

# cd /var/run/gluster/shared_storage/ # mkdir nfs-ganeshaCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 新しいサービスおよびポートのファイアウォール設定を有効にします。『『Red Hat Gluster Storage 3.5 Administration Guide』』の「『Getting Started』」を参照してください。

- Samba/CTDB を使用する場合は、以下を行います。

- CTDB を起動する前に、以下のコマンドを実行して

/gluster/lockをマウントします。mount <ctdb_volume_name> mount -t glusterfs server:/ctdb_volume_name /gluster/lock/

# mount <ctdb_volume_name> # mount -t glusterfs server:/ctdb_volume_name /gluster/lock/Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Samba サーバーの mount コマンドの出力で

lockをチェックして、lock ボリュームが正しくマウントされていることを確認します。mount | grep 'lock' ... <hostname>:/<ctdb_volume_name>.tcp on /gluster/lock type fuse.glusterfs (rw,relatime,user_id=0,group_id=0,default_permissions,allow_other,max_read=131072)

# mount | grep 'lock' ... <hostname>:/<ctdb_volume_name>.tcp on /gluster/lock type fuse.glusterfs (rw,relatime,user_id=0,group_id=0,default_permissions,allow_other,max_read=131072)Copy to Clipboard Copied! Toggle word wrap Toggle overflow - SMB 経由でアクセスされるボリュームをホストするすべてのサーバーを更新している場合、以下のコマンドを実行して CTDB サービスおよび Samba サービスを起動します。Red Hat Enterprise Linux 7 および Red Hat Enterprise Linux 8 の場合:

systemctl start ctdb

# systemctl start ctdbCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 6 の場合:service ctdb start

# service ctdb startCopy to Clipboard Copied! Toggle word wrap Toggle overflow - CTDB サービスおよび SMB サービスが起動していることを確認するには、以下のコマンドを実行します。

ps axf | grep -E '(ctdb|smb|winbind|nmb)[d]'

ps axf | grep -E '(ctdb|smb|winbind|nmb)[d]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- NFS-Ganesha を使用する場合:

ganesha.confファイルおよびganesha-ha.confファイル、および/etc/ganesha/exportsディレクトリーを/var/run/gluster/shared_storage/nfs-ganeshaディレクトリーにコピーします。cd /etc/ganesha/ cp ganesha.conf ganesha-ha.conf /var/run/gluster/shared_storage/nfs-ganesha/ cp -r exports/ /var/run/gluster/shared_storage/nfs-ganesha/

# cd /etc/ganesha/ # cp ganesha.conf ganesha-ha.conf /var/run/gluster/shared_storage/nfs-ganesha/ # cp -r exports/ /var/run/gluster/shared_storage/nfs-ganesha/Copy to Clipboard Copied! Toggle word wrap Toggle overflow ganesha.confファイルのエクスポートエントリーのパスを更新します。sed -i 's/\/etc\/ganesha/\/var\/run\/gluster\/shared_storage\/nfs-ganesha/' /var/run/gluster/shared_storage/nfs-ganesha/ganesha.conf

# sed -i 's/\/etc\/ganesha/\/var\/run\/gluster\/shared_storage\/nfs-ganesha/' /var/run/gluster/shared_storage/nfs-ganesha/ganesha.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 以下のコマンドを実行して、既存のクラスター設定をクリーンアップします。

/usr/libexec/ganesha/ganesha-ha.sh --cleanup /var/run/gluster/shared_storage/nfs-ganesha

/usr/libexec/ganesha/ganesha-ha.sh --cleanup /var/run/gluster/shared_storage/nfs-ganeshaCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Enterprise Linux 7.4 以降にアップグレードする場合は、以下の SELinux ブール値を設定します。

setsebool -P ganesha_use_fusefs on

# setsebool -P ganesha_use_fusefs onCopy to Clipboard Copied! Toggle word wrap Toggle overflow - nfs-ganesha サービスを起動し、すべてのノードが機能していることを確認します。

gluster nfs-ganesha enable

# gluster nfs-ganesha enableCopy to Clipboard Copied! Toggle word wrap Toggle overflow - すべてのボリュームで NFS-Ganesha を有効にします。

gluster volume set volname ganesha.enable on

# gluster volume set volname ganesha.enable onCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.1.2. Red Hat Satellite Server にサブスクライブしているシステム向けの Red Hat Gluster Storage 3.5 へのアップグレード

手順5.3 アップグレード前

- オペレーティングシステムパーティション上ではない場所に、設定ディレクトリーとファイルをバックアップします。

/var/lib/glusterd/etc/samba/etc/ctdb/etc/glusterfs/var/lib/samba/var/lib/ctdb/var/run/gluster/shared_storage/nfs-ganesha

注記3.5 Batch Update 3 のリリースにより、共有ストレージのマウントポイントが /var/run/gluster/ から /run/gluster/ に変更されました。NFS-Ganesha を使用する場合は、すべてのノードから以下のファイルをバックアップします。/run/gluster/shared_storage/nfs-ganesha/exports/export.*.conf/etc/ganesha/ganesha.conf/etc/ganesha/ganesha-ha.conf

Red Hat Gluster Storage 3.3 から 3.4 以降のリリースにアップグレードする場合は、すべてのノードのブリックの root で以下のコマンドを個別に実行し、すべての xattr をバックアップします。find ./ -type d ! -path "./.*" ! -path "./" | xargs getfattr -d -m. -e hex > /var/log/glusterfs/xattr_dump_brick_name

# find ./ -type d ! -path "./.*" ! -path "./" | xargs getfattr -d -m. -e hex > /var/log/glusterfs/xattr_dump_brick_nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow - すべてのクライアントから gluster ボリュームをアンマウントします。クライアントで以下のコマンドを使用して、マウントポイントからボリュームをアンマウントします。

umount mount-point

# umount mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow - NFS-Ganesha を使用する場合は、gluster サーバーで以下のコマンドを実行して nfs-ganesha サービスを無効にします。

gluster nfs-ganesha disable

# gluster nfs-ganesha disableCopy to Clipboard Copied! Toggle word wrap Toggle overflow - gluster サーバーで、共有ボリュームを無効にします。

gluster volume set all cluster.enable-shared-storage disable

# gluster volume set all cluster.enable-shared-storage disableCopy to Clipboard Copied! Toggle word wrap Toggle overflow - すべてのボリュームを停止します。

for vol in `gluster volume list`; do gluster --mode=script volume stop $vol; sleep 2s; done

# for vol in `gluster volume list`; do gluster --mode=script volume stop $vol; sleep 2s; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow - すべてのボリュームが停止していることを確認します。

gluster volume info

# gluster volume infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 以下のコマンドを使用して、すべてのサーバーで

glusterdサービスを停止します。service glusterd stop pkill glusterfs pkill glusterfsd

# service glusterd stop # pkill glusterfs # pkill glusterfsdCopy to Clipboard Copied! Toggle word wrap Toggle overflow - pcsd サービスを停止します。

systemctl stop pcsd

# systemctl stop pcsdCopy to Clipboard Copied! Toggle word wrap Toggle overflow

手順5.4 Satellite を使用したアップグレード

- Red Hat Satellite Server でアクティベーションキーを作成し、以下のチャンネルに関連付けます。詳細は、「Red Hat Satellite Server からのインストール」 を参照してください。

- Red Hat Enterprise Linux 6.7 以降の場合:

Base Channel: Red Hat Enterprise Linux Server (v.6 for 64-bit x86_64) Child channels: RHEL Server Scalable File System (v. 6 for x86_64) Red Hat Gluster Storage Server 3 (RHEL 6 for x86_64)

Base Channel: Red Hat Enterprise Linux Server (v.6 for 64-bit x86_64) Child channels: RHEL Server Scalable File System (v. 6 for x86_64) Red Hat Gluster Storage Server 3 (RHEL 6 for x86_64)Copy to Clipboard Copied! Toggle word wrap Toggle overflow Samba を使用する場合は、以下のチャンネルを追加します。Red Hat Gluster 3 Samba (RHEL 6 for x86_64)

Red Hat Gluster 3 Samba (RHEL 6 for x86_64)Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Enterprise Linux 7 の場合

Base Channel: Red Hat Enterprise Linux Server (v.7 for 64-bit x86_64) Child channels: RHEL Server Scalable File System (v. 7 for x86_64) Red Hat Gluster Storage Server 3 (RHEL 7 for x86_64)

Base Channel: Red Hat Enterprise Linux Server (v.7 for 64-bit x86_64) Child channels: RHEL Server Scalable File System (v. 7 for x86_64) Red Hat Gluster Storage Server 3 (RHEL 7 for x86_64)Copy to Clipboard Copied! Toggle word wrap Toggle overflow Samba を使用する場合は、以下のチャンネルを追加します。Red Hat Gluster 3 Samba (RHEL 7 for x86_64)

Red Hat Gluster 3 Samba (RHEL 7 for x86_64)Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- 以下の手順を実行して、Red Hat Network Satellite からシステムの登録を解除します。

- Red Hat Network Satellite サーバーにログインします。

- 上部のナビゲーションバーの Systems タブをクリックし、System List で古いシステムまたは重複システムの名前をクリックします。

- ページの右上にある delete system リンクをクリックします。

- システムプロファイルの削除を確認するには、Delete System ボタンをクリックします。

- 先の手順で作成した認証情報とアクティベーションキーを使用して、Red Hat Gluster Storage サーバーで以下のコマンドを実行します。これにより、システムが Red Hat Network Satellite Server の Red Hat Gluster Storage 3.5 チャンネルに再登録されます。

rhnreg_ks --username username --password password --force --activationkey Activation Key ID

# rhnreg_ks --username username --password password --force --activationkey Activation Key IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow - チャンネルのサブスクリプションが更新されていることを確認します。Red Hat Enterprise Linux 6.7 以降で、Samba を使用する場合は、以下のチャンネルと

rh-gluster-3-samba-for-rhel-6-server-rpmsチャンネルを検索します。rhn-channel --list rhel-6-server-rpms rhel-scalefs-for-rhel-6-server-rpms rhs-3-for-rhel-6-server-rpms

# rhn-channel --list rhel-6-server-rpms rhel-scalefs-for-rhel-6-server-rpms rhs-3-for-rhel-6-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 7 では、Samba を使用する場合は、以下のチャンネルとrh-gluster-3-samba-for-rhel-7-server-rpmsチャンネルを検索します。rhn-channel --list rhel-7-server-rpms rh-gluster-3-for-rhel-7-server-rpms

# rhn-channel --list rhel-7-server-rpms rh-gluster-3-for-rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Gluster Storage 3.5 にアップグレードします。

yum update

# yum updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要以下のコマンドを実行して、Red Hat Enterprise Linux 7 に nfs-ganesha-selinux をインストールします。yum install nfs-ganesha-selinux

# yum install nfs-ganesha-selinuxCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、Red Hat Enterprise Linux 8 に nfs-ganesha-selinux をインストールします。dnf install glusterfs-ganesha

# dnf install glusterfs-ganeshaCopy to Clipboard Copied! Toggle word wrap Toggle overflow - サーバーを再起動して、ボリュームとデータの整合性チェックを実行します。

- すべてのノードがアップグレードされたら、以下のコマンドを実行してクラスターの

op-versionを更新します。これにより、クラスター内の互換性の問題を防ぐことができます。gluster volume set all cluster.op-version 70200

# gluster volume set all cluster.op-version 70200Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記70200は、Red Hat Gluster Storage 3.5 のcluster.op-version値です。Ater は cluster-op バージョンをアップグレードするため、指定したコマンドを使用してボリュームの詳細なエントリー修復を有効にします。この機能は、Red Hat Gluster Storage 3.5 へのアップグレード後にデフォルトで有効になりましたが、op-version を増やした後にのみ有効になります。他のバージョンの正しいgluster volume heal $VOLNAME granular-entry-heal enable

gluster volume heal $VOLNAME granular-entry-heal enableCopy to Clipboard Copied! Toggle word wrap Toggle overflow cluster.op-version値については、「Red Hat Gluster Storage のソフトウェアコンポーネントおよびバージョン」 を参照してください。 - すべてのボリュームを起動します。

for vol in `gluster volume list`; do gluster --mode=script volume start $vol; sleep 2s; done

# for vol in `gluster volume list`; do gluster --mode=script volume start $vol; sleep 2s; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow - NFS-Ganesha を使用している場合:

- ボリュームのエクスポート情報を

ganesha.confのバックアップコピーから、新しい/etc/ganesha/ganesha.confファイルにコピーします。バックアップファイルのエクスポート情報は、以下のようになります。%include "/var/run/gluster/shared_storage/nfs-ganesha/exports/export.v1.conf" %include "/var/run/gluster/shared_storage/nfs-ganesha/exports/export.v2.conf" %include "/var/run/gluster/shared_storage/nfs-ganesha/exports/export.v3.conf"

%include "/var/run/gluster/shared_storage/nfs-ganesha/exports/export.v1.conf" %include "/var/run/gluster/shared_storage/nfs-ganesha/exports/export.v2.conf" %include "/var/run/gluster/shared_storage/nfs-ganesha/exports/export.v3.conf"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記3.5 Batch Update 3 のリリースにより、共有ストレージのマウントポイントが /var/run/gluster/ から /run/gluster/ に変更されました。 - バックアップディレクトリーから以下のコマンドを実行し、バックアップボリュームのエクスポートファイルをバックアップディレクトリーから

/etc/ganesha/exportsにコピーします。cp export.* /etc/ganesha/exports/

# cp export.* /etc/ganesha/exports/Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- 共有ボリュームを有効にします。

gluster volume set all cluster.enable-shared-storage enable

# gluster volume set all cluster.enable-shared-storage enableCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 共有ストレージボリュームがサーバーにマウントされていることを確認します。ボリュームがマウントされていない場合は、以下のコマンドを実行します。

mount -t glusterfs hostname:gluster_shared_storage /var/run/gluster/shared_storage

# mount -t glusterfs hostname:gluster_shared_storage /var/run/gluster/shared_storageCopy to Clipboard Copied! Toggle word wrap Toggle overflow /var/run/gluster/shared_storage/nfs-ganeshaディレクトリーが作成されていることを確認します。cd /var/run/gluster/shared_storage/ mkdir nfs-ganesha

# cd /var/run/gluster/shared_storage/ # mkdir nfs-ganeshaCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 新しいサービスおよびポートのファイアウォール設定を有効にします。『『Red Hat Gluster Storage 3.5 Administration Guide』』の「『Getting Started』」を参照してください。

- Samba/CTDB を使用する場合は、以下を行います。

- CTDB を起動する前に、以下のコマンドを実行して

/gluster/lockをマウントします。mount <ctdb_volume_name> mount -t glusterfs server:/ctdb_volume_name /gluster/lock/

# mount <ctdb_volume_name> # mount -t glusterfs server:/ctdb_volume_name /gluster/lock/Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Samba サーバーの mount コマンドの出力で

lockをチェックして、lock ボリュームが正しくマウントされていることを確認します。mount | grep 'lock' ... <hostname>:/<ctdb_volume_name>.tcp on /gluster/lock type fuse.glusterfs (rw,relatime,user_id=0,group_id=0,default_permissions,allow_other,max_read=131072)

# mount | grep 'lock' ... <hostname>:/<ctdb_volume_name>.tcp on /gluster/lock type fuse.glusterfs (rw,relatime,user_id=0,group_id=0,default_permissions,allow_other,max_read=131072)Copy to Clipboard Copied! Toggle word wrap Toggle overflow - SMB 経由でアクセスされるボリュームをホストするすべてのサーバーを更新している場合、以下のコマンドを実行して CTDB サービスおよび Samba サービスを起動します。Red Hat Enterprise Linux 7 および Red Hat Enterprise Linux 8 の場合:

systemctl start ctdb

# systemctl start ctdbCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 6 の場合:service ctdb start

# service ctdb startCopy to Clipboard Copied! Toggle word wrap Toggle overflow - CTDB サービスおよび SMB サービスが起動していることを確認するには、以下のコマンドを実行します。

ps axf | grep -E '(ctdb|smb|winbind|nmb)[d]'

ps axf | grep -E '(ctdb|smb|winbind|nmb)[d]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- NFS-Ganesha を使用する場合:

ganesha.confファイルおよびganesha-ha.confファイル、および/etc/ganesha/exportsディレクトリーを/var/run/gluster/shared_storage/nfs-ganeshaディレクトリーにコピーします。cd /etc/ganesha/ cp ganesha.conf ganesha-ha.conf /var/run/gluster/shared_storage/nfs-ganesha/ cp -r exports/ /var/run/gluster/shared_storage/nfs-ganesha/

# cd /etc/ganesha/ # cp ganesha.conf ganesha-ha.conf /var/run/gluster/shared_storage/nfs-ganesha/ # cp -r exports/ /var/run/gluster/shared_storage/nfs-ganesha/Copy to Clipboard Copied! Toggle word wrap Toggle overflow ganesha.confファイルのエクスポートエントリーのパスを更新します。sed -i 's/\/etc\/ganesha/\/var\/run\/gluster\/shared_storage\/nfs-ganesha/' /var/run/gluster/shared_storage/nfs-ganesha/ganesha.conf

# sed -i 's/\/etc\/ganesha/\/var\/run\/gluster\/shared_storage\/nfs-ganesha/' /var/run/gluster/shared_storage/nfs-ganesha/ganesha.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 以下のコマンドを実行して、既存のクラスター設定をクリーンアップします。

/usr/libexec/ganesha/ganesha-ha.sh --cleanup /var/run/gluster/shared_storage/nfs-ganesha

/usr/libexec/ganesha/ganesha-ha.sh --cleanup /var/run/gluster/shared_storage/nfs-ganeshaCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Enterprise Linux 7.4 以降にアップグレードする場合は、以下の SELinux ブール値を設定します。

setsebool -P ganesha_use_fusefs on

# setsebool -P ganesha_use_fusefs onCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- ctdb サービス (および使用している場合は nfs-ganesha サービス) を起動し、すべてのノードが機能していることを確認します。

systemctl start ctdb gluster nfs-ganesha enable

# systemctl start ctdb # gluster nfs-ganesha enableCopy to Clipboard Copied! Toggle word wrap Toggle overflow - このデプロイメントで NFS-Ganesha を使用する場合は、すべてのボリュームで NFS-Ganesha を有効にします。

gluster volume set volname ganesha.enable on

# gluster volume set volname ganesha.enable onCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.1.3. Offline Software Upgrade の特別な考慮事項

5.1.3.1. CTDB 設定ファイルの移行

- 設定ファイルを移行する一時的なディレクトリーを作成します。

mkdir /tmp/ctdb-migration

# mkdir /tmp/ctdb-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow - CTDB 設定の移行スクリプトを実行します。

./usr/share/doc/ctdb-4.9.x/examples/config_migrate.sh -o /tmp/ctdb-migration /etc/sysconfig/ctdb

# ./usr/share/doc/ctdb-4.9.x/examples/config_migrate.sh -o /tmp/ctdb-migration /etc/sysconfig/ctdbCopy to Clipboard Copied! Toggle word wrap Toggle overflow このスクリプトは、CTDB 設定ディレクトリーが/etc/ctdbであることを前提としています。これがセットアップに対して適切でない場合、-dオプションで代替の設定ディレクトリーを指定します。以下は例になります。./usr/share/doc/ctdb-4.9.x/examples/config_migrate.sh -o /tmp/ctdb-migration /etc/sysconfig/ctdb -d ctdb-config-dir

# ./usr/share/doc/ctdb-4.9.x/examples/config_migrate.sh -o /tmp/ctdb-migration /etc/sysconfig/ctdb -d ctdb-config-dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow /tmp/ctdb-migrationディレクトリーに以下のファイルが含まれていることを確認します。commands.shctdb.confscript.optionsctdb.tunables(追加の変更が必要な場合)ctdb.sysconfig(追加の変更が必要な場合)README.warn(追加の変更が必要な場合)

- 現在の設定ファイルをバックアップします。

mv /etc/ctdb/ctdb.conf /etc/ctdb/ctdb.conf.default

# mv /etc/ctdb/ctdb.conf /etc/ctdb/ctdb.conf.defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 新しい設定ファイルをインストールします。

mv /tmp/ctdb-migration/ctdb.conf /etc/ctdb/ctdb.conf mv script.options /etc/ctdb/

# mv /tmp/ctdb-migration/ctdb.conf /etc/ctdb/ctdb.conf # mv script.options /etc/ctdb/Copy to Clipboard Copied! Toggle word wrap Toggle overflow commands.shファイルを実行可能にして実行します。chmod +x /tmp/ctdb-migration/commands.sh ./tmp/ctdb-migration/commands.sh

# chmod +x /tmp/ctdb-migration/commands.sh # ./tmp/ctdb-migration/commands.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow /tmp/ctdb-migration/ctdb.tunablesが存在する場合は、/etc/ctdbディレクトリーに移動します。cp /tmp/ctdb-migration/ctdb.tunables /etc/ctdb

# cp /tmp/ctdb-migration/ctdb.tunables /etc/ctdbCopy to Clipboard Copied! Toggle word wrap Toggle overflow /tmp/ctdb-migration/ctdb.sysconfigが存在する場合は、古い/etc/sysconfig/ctdbファイルのバックアップを取得し、これを/tmp/ctdb-migration/ctdb.sysconfigに置き換えます。mv /etc/sysconfig/ctdb /etc/sysconfig/ctdb.old mv /tmp/ctdb-migration/ctdb.sysconfig /etc/sysconfig/ctdb

# mv /etc/sysconfig/ctdb /etc/sysconfig/ctdb.old # mv /tmp/ctdb-migration/ctdb.sysconfig /etc/sysconfig/ctdbCopy to Clipboard Copied! Toggle word wrap Toggle overflow それ以外の場合は、古い/etc/sysconfig/ctdbファイルのバックアップを取得し、これを/etc/sysconfig/ctdb.rpmnewに置き換えます。mv /etc/sysconfig/ctdb /etc/sysconfig/ctdb.old mv /etc/sysconfig/ctdb.rpmnew /etc/sysconfig/ctdb

# mv /etc/sysconfig/ctdb /etc/sysconfig/ctdb.old # mv /etc/sysconfig/ctdb.rpmnew /etc/sysconfig/ctdbCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2. Red Hat Gluster Storage 3.4 から Red Hat Gluster Storage 3.5 へのインサービスソフトウェアアップグレード

/etc/ganesha フォルダーにganesha.conf.rpmnewという名前で保存されます。古い設定ファイルは、インサービスアップグレードプロセス時に上書きされません。ただし、アップグレード後、ganesha.conf.rpmnewから、/etc/ganeshaフォルダーにある既存のganesha.confファイルに、新しい設定変更を手動でコピーする必要があります。

5.2.1. アップグレード前のタスク

5.2.1.1. Red Hat Gluster Storage 3.5 のアップグレード要件

- インサービスソフトウェアアップグレードは、分散型バージョンの Arbiter、イレイジャーコーディング (分散)、および Three Way レプリケーションのボリュームタイプでサポートされます。これは完全な分散ボリュームではサポートされません。

- 既存の環境にスナップショットを使用する場合は、各ブリックは独立したシンプロビジョニング論理ボリューム (LV) である必要があります。スナップショットを使用する予定がない場合、「シック」プロビジョニングされたボリュームは引き続きサポートされます。

- ブリックを含む論理ボリュームは、その他の目的では使用できません。

- Red Hat Gluster Storage 3.4 以降では、リニア LVM およびシン LV がサポートされています。詳細は、https://access.redhat.com/documentation/ja-jp/red_hat_enterprise_linux/7/html-single/logical_volume_manager_administration/index#LVM_components を参照してください。

- サーバー側のクォーラム (定足数) が有効にされている場合、1 つのノードをダウンしてもサーバー側のクォーラム (定足数) に違反しないことを確認します。ダミーのピアを追加して、以下のコマンドを使用し、ローリングアップグレードが完了するまでサーバー側のクォーラム (定足数) の違反が生じないようにします。

gluster peer probe dummynode

# gluster peer probe dummynodeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記geo レプリケーションセッションがある場合は、『『Red Hat Gluster Storage Administration Guide』』の「『Starting Geo-replication for a New Brick or New Node』」のセクションを参照してください。たとえば、各マシンに 2 ノードと 1 ブリックのある単純なレプリケーションボリュームについてサーバー側のクォーラム (定足数) の割合がデフォルト値(>50%) に設定される場合、上記のコマンドを使用して、ブリックを含まないダミーノードを信頼できるストレージプールに追加し、ボリュームの高可用性を確保する必要があります。3 ノードで構成されるクラスターでは、サーバー側のクォーラム (定足数) の割合が 77% に設定される場合、1 つのノードがダウンするとサーバー側のクォーラム (定足数) の違反が生じます。このシナリオでは、サーバー側のクォーラム (定足数) を満たすために 2 つのダミーノードを追加する必要があります。 - マスターとスレーブ間で実行されている geo レプリケーションセッションを停止します。

gluster volume geo-replication MASTER_VOL SLAVE_HOST::SLAVE_VOL stop

# gluster volume geo-replication MASTER_VOL SLAVE_HOST::SLAVE_VOL stopCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 以下のコマンドを使用して、インサービスソフトウェアアップグレードに進む前に保留中の自己修復がないことを確認します。

gluster volume heal volname info

# gluster volume heal volname infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Gluster Storage サーバーが必要なチャンネルに登録されていることを確認します。Red Hat Enterprise Linux 6 の場合:

rhel-6-server-rpms rhel-scalefs-for-rhel-6-server-rpms rhs-3-for-rhel-6-server-rpms