This documentation is for a release that is no longer maintained

See documentation for the latest supported version.管理ガイド

Administering Red Hat OpenShift Dev Spaces 3.0

概要

第1章 インストールの準備

OpenShift Dev Spaces インストールを準備するには、OpenShift Dev Spaces エコシステムおよびデプロイメントの制約について確認します。

1.1. サポートされるプラットフォーム

OpenShift Dev Spaces 3.0 は、一覧表示されたインストール方法を使用して、一覧表示されたプラットフォームで利用できます。

| プラットフォーム | アーキテクチャー | デプロイメント方法 |

|---|---|---|

| OpenShift Container Platform 4.10 |

| |

| OpenShift Dedicated 4.10 |

| |

| Red Hat OpenShift Service on AWS (ROSA) 4.10 |

|

1.2. OpenShift Dev Spaces アーキテクチャー

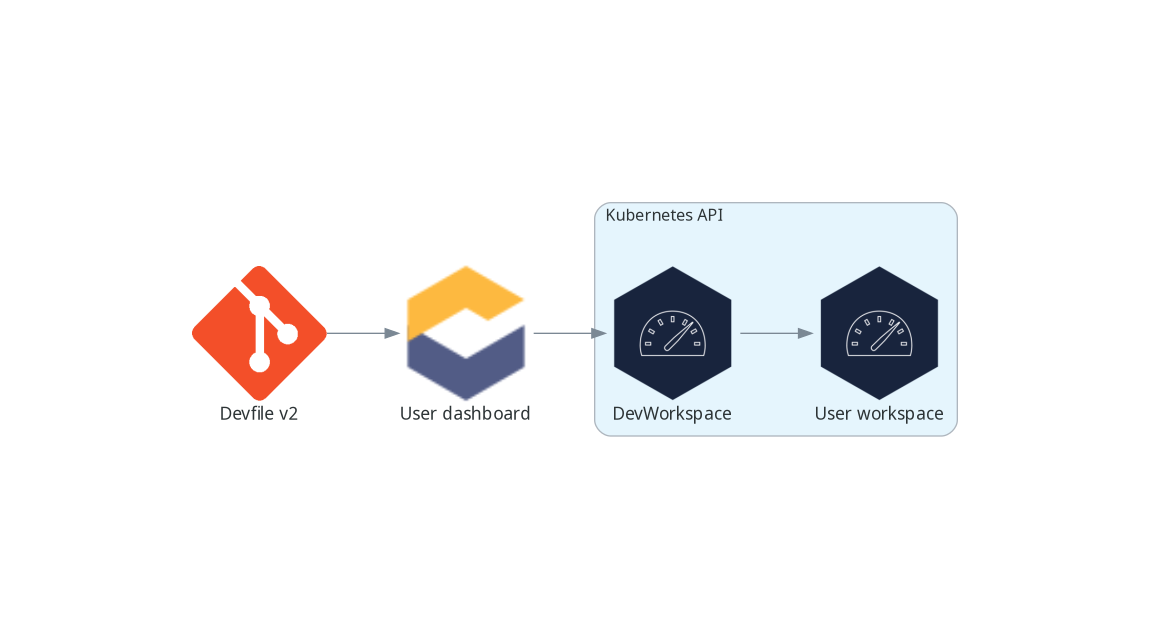

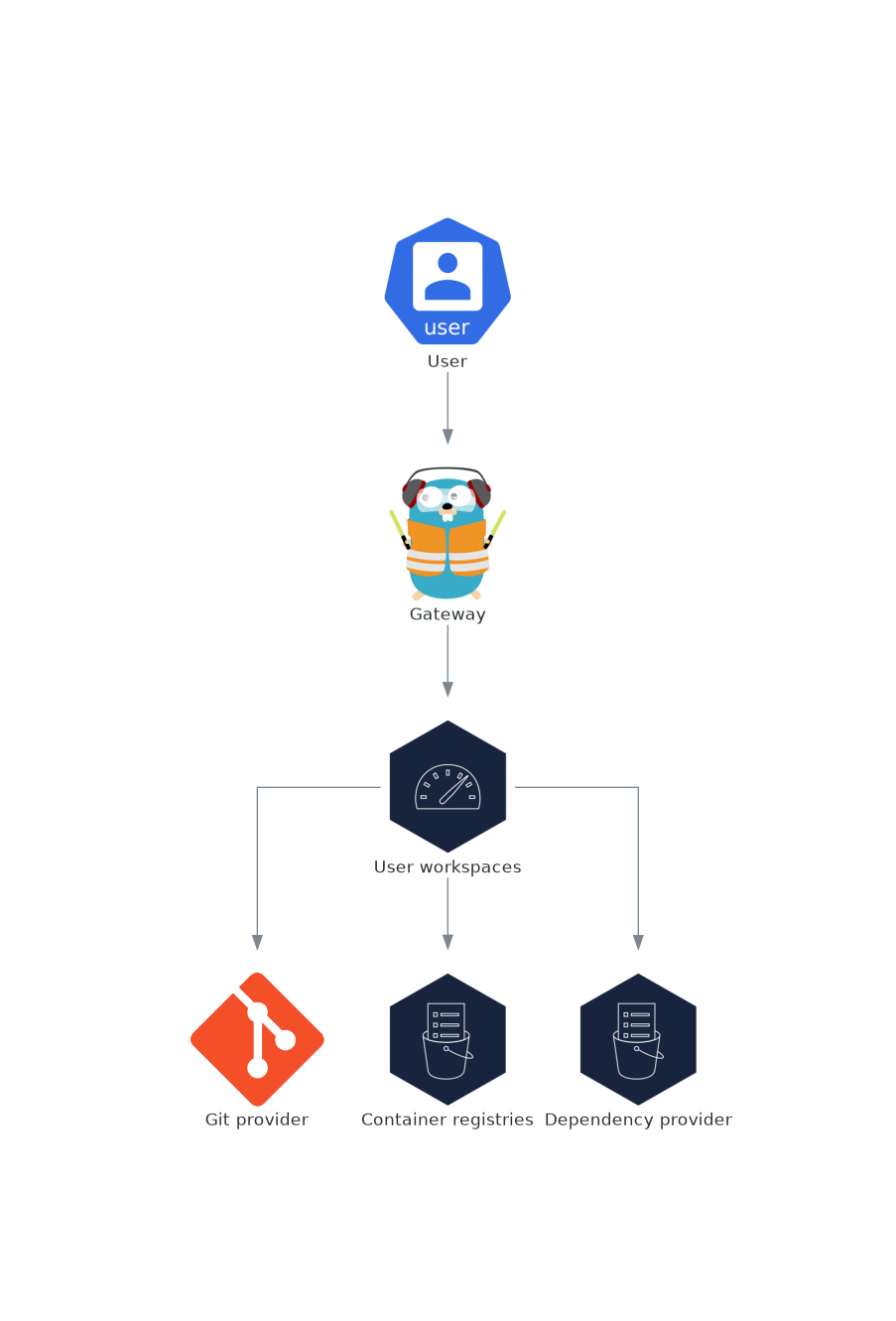

図1.1 Dev Workspace Operator を使用した高度な OpenShift DevSpaces アーキテクチャー

OpenShift Dev Spaces は、3 つのコンポーネントのグループで実行されます。

- OpenShift Dev Spaces サーバーコンポーネント

- ユーザープロジェクトおよびワークスペースの管理。主な構成要素はユーザーダッシュボードで、ユーザーはここから自分のワークスペースを制御します。

- DevWorkspace operator

-

User ワークスペースの実行に必要な OpenShift オブジェクトを作成し、制御します。

Pods、Services、PeristentVolumesを含みます。 - User ワークスペース

- コンテナーベースの開発環境、IDE を含みます。

これらの OpenShift の機能の役割は中心的なものです。

- DevWorkspace カスタムリソース

- ユーザーワークスペースを表す有効な OpenShift オブジェクト。OpenShift Dev Spaces で操作します。3 つのグループのコンポーネントのコミュニケーションチャンネルとなります。

- OpenShift のロールベースアクセスコントロール (RBAC)

- すべてのリソースへのアクセスを制御します。

関連情報

1.2.1. OpenShift Dev Spaces サーバーコンポーネント

OpenShift Dev Spaces サーバーコンポーネントにより、マルチテナンシーとワークスペースの管理が確保されます。

図1.2 Dev Workspace Operator と対話する OpenShift DevSpaces サーバーコンポーネント

関連情報

1.2.1.1. OpenShift Dev Spaces 演算子

OpenShift Dev Spaces Operator は、OpenShift Dev Spaces サーバーコンポーネントの完全なライフサイクル管理を行います。これには、以下が含まれます。

CheClusterカスタムリソース定義 (CRD)-

CheClusterOpenShift オブジェクトを定義します。 - OpenShift Dev Spaces コントローラー

- Pod、サービス、永続ボリュームなどの OpenShift Dev Space インスタンスを実行するために必要な OpenShift オブジェクトを作成し、制御します。

CheClusterカスタムリソース (CR)OpenShift Dev Spaces Operator を持つクラスターでは、

CheClusterカスタムリソース (CR) を作成できます。OpenShift Dev Spaces オペレーターは、この OpenShift Dev Spaces インスタンス上で OpenShift Dev Spaces サーバーコンポーネントの完全なライフサイクル管理を行います。

1.2.1.2. DevWorkspace operator

DevWorkspace Operator は OpenShift を拡張して DevWorkspace サポートを提供します。これには、以下が含まれます。

- DevWorkspace のカスタムリソース定義

- Devfile v2 仕様から DevWorkspace OpenShift オブジェクトを定義します。

- DevWorkspace コントローラー

- Pod、サービス、永続ボリュームなど、DevWorkspace の実行に必要な OpenShift オブジェクトを作成して制御します。

- DevWorkspace カスタムリソース

- DevWorkspace 演算子があるクラスターでは、DevWorkspace カスタムリソース (CR) を作成することができます。DevWorkspace CR は、Devfile を OpenShift で表現したものです。OpenShift クラスター内の User ワークスペースを定義します。

関連情報

1.2.1.3. ゲートウェイ

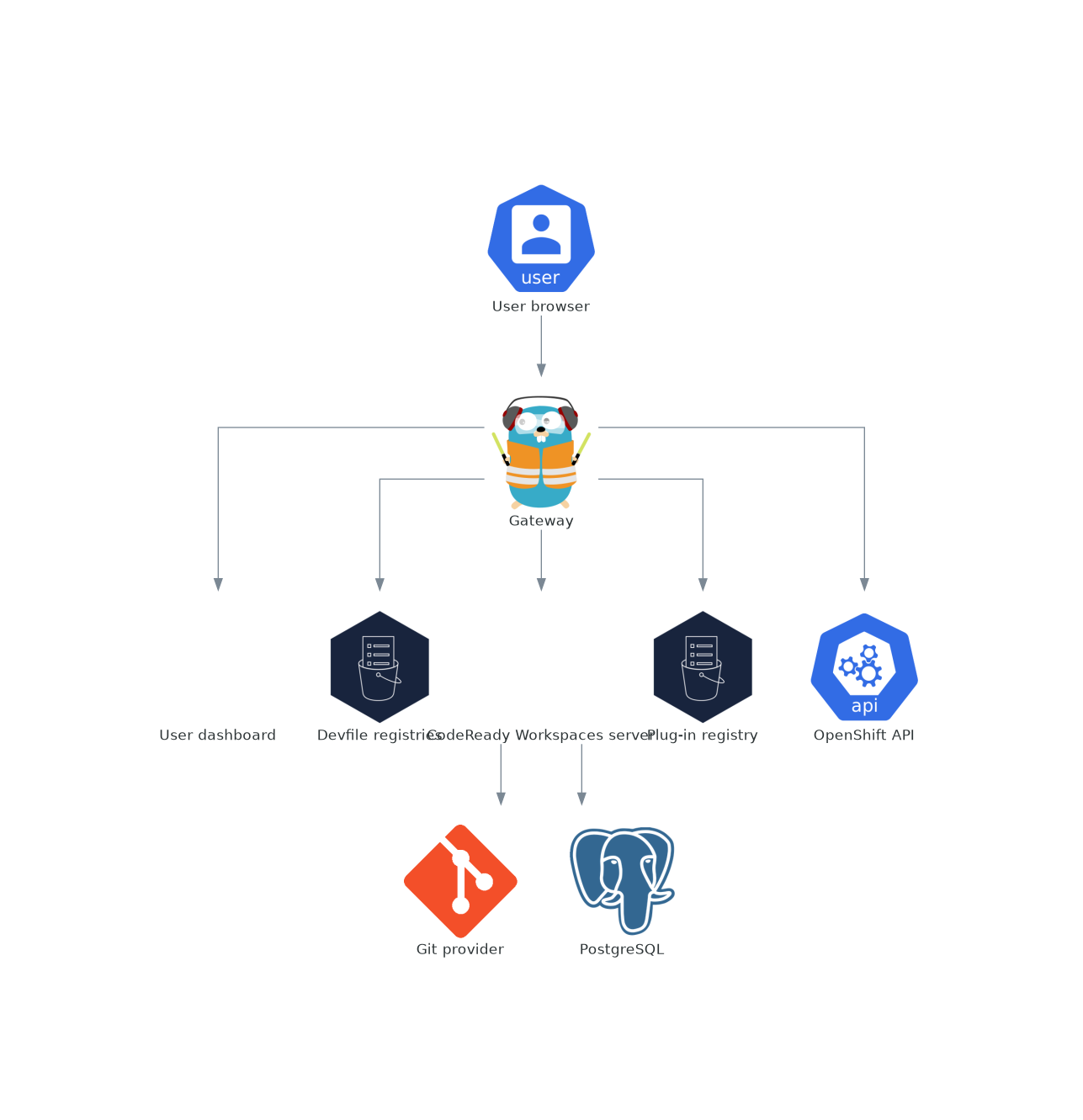

OpenShift Dev Spaces ゲートウェイには、以下のロールがあります。

- 要求をルーティングする。Traefik を使用します。

- OpenID Connect(OIDC)でユーザーを認証する。OpenShift OAuth2 プロキシー を使用します。

- OpenShift RoleBased Access Control(RBAC)ポリシーを適用して、OpenShift Dev Spaces リソースへのアクセスを制御します。'kube-rbac-proxy' を使用します。

OpenShift Dev Spaces Operator はこれを che-gateway Deployment として管理します。

以下へのアクセスを制御します。

図1.3 OpenShift Dev Spaces ゲートウェイと他のコンポーネントとの対話

関連情報

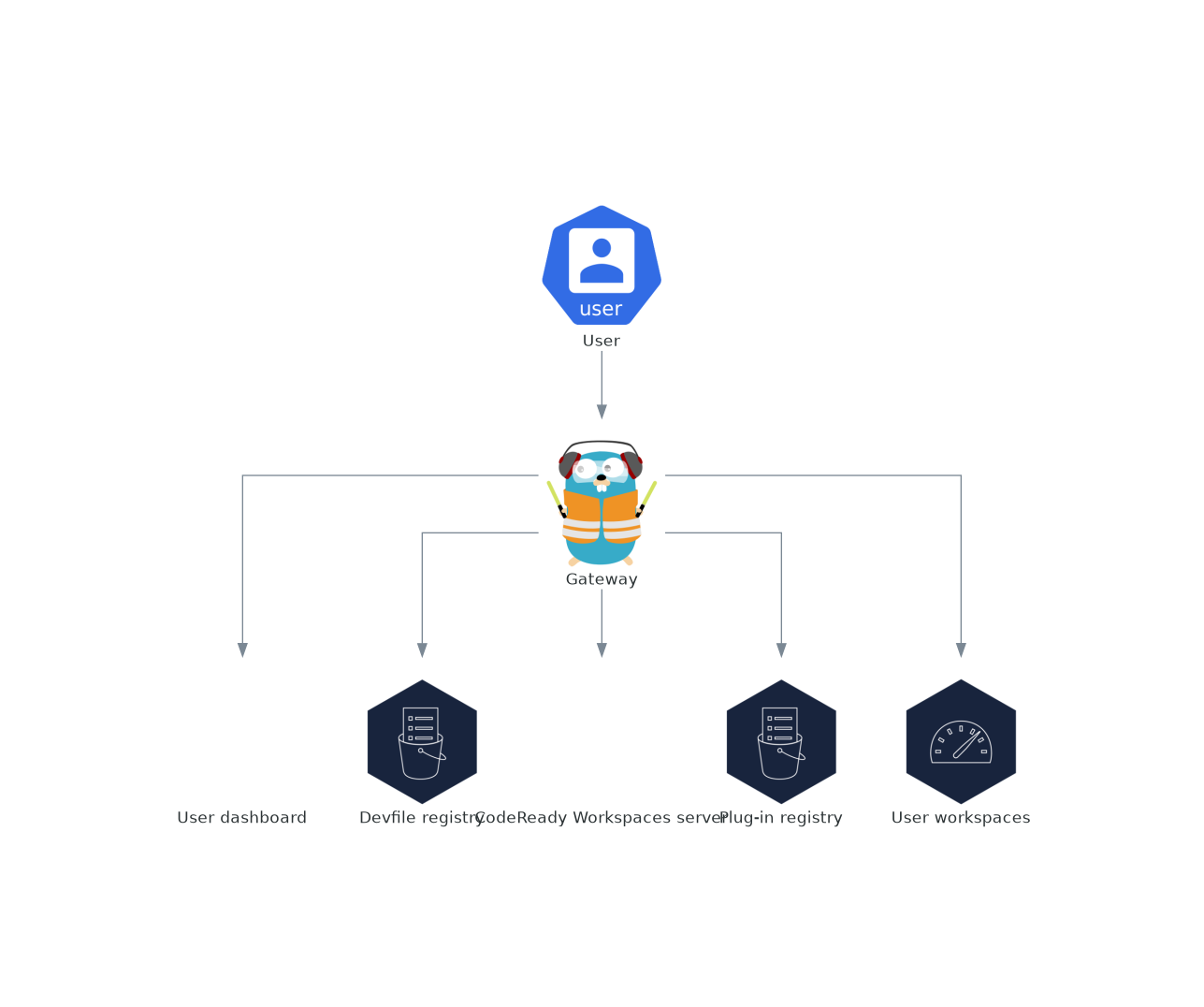

1.2.1.4. ユーザーダッシュボード

ユーザーダッシュボードは、Red Hat OpenShift Dev Spaces のランディングページです。OpenShift Dev Spaces ユーザーは、ユーザーダッシュボードを参照してワークスペースにアクセスし、管理します。これは React のアプリケーションです。OpenShift Dev Spaces デプロイメントは、devspaces-dashboard Deployment で起動します。

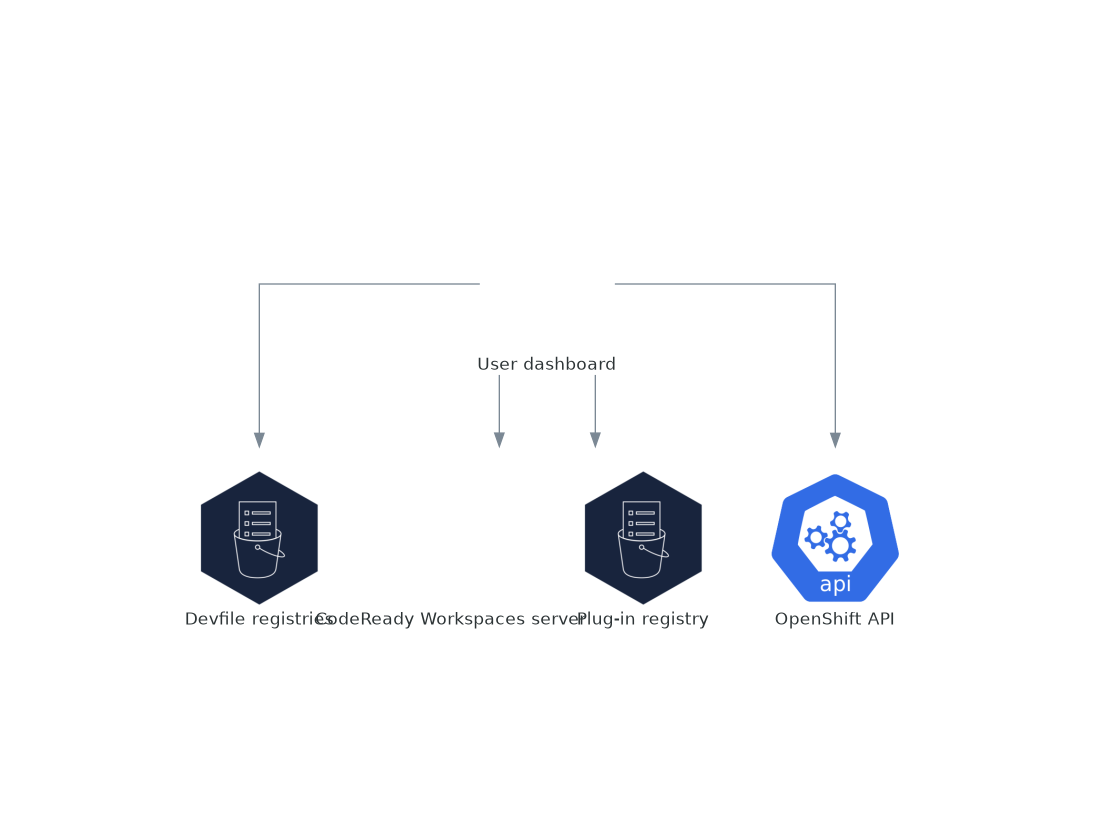

以下にアクセスする必要があります。

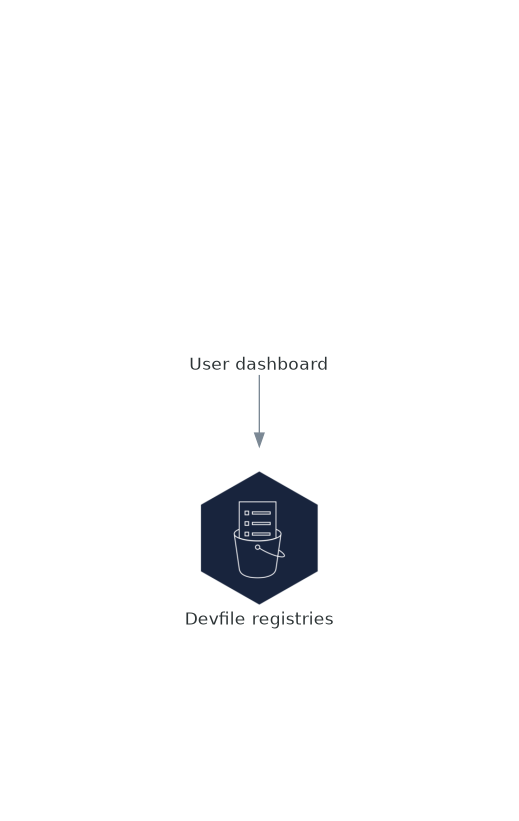

- 「Devfile レジストリー」

- 「OpenShift Dev Spaces サーバー」

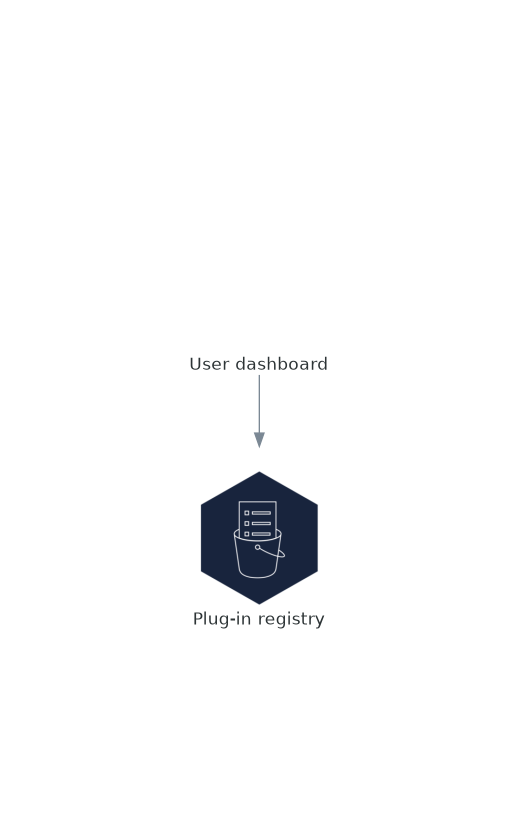

- 「プラグインレジストリー」

- OpenShift API

図1.4 User ダッシュボードと他のコンポーネントとの対話

ユーザーがユーザーダッシュボードにワークスペースの起動を要求すると、ユーザーダッシュボードはこの一連のアクションを実行します。

- ユーザーがコードサンプルからワークスペースを作成する際に、「Devfile レジストリー」 から devfile を収集します。

- リポジトリー URL を 「OpenShift Dev Spaces サーバー」 に送信し、ユーザーがリモート devfile からワークスペースを作成する際に devfile が返されることを想定します。

- ワークスペースを記述した devfile を読み込みます。

- 「プラグインレジストリー」 から追加のメタデータを収集します。

- その情報を DevWorkspace Custom Resource に変換します。

- OpenShift API を使用して、ユーザープロジェクトに DevWorkspace Custom Resource を作成します。

- DevWorkspace カスタムリソースのステータスを監視します。

- 実行中のワークスペース IDE にユーザーをリダイレクトします。

1.2.1.5. Devfile レジストリー

関連情報

OpenShift Dev Spaces devfile レジストリーは、すぐに使用できるワークスペースを作成するためのサンプル devfile の一覧を提供するサービスです。「ユーザーダッシュボード」 は、Dashboard → Create Workspace ページにサンプルリストを表示します。各サンプルには、Devfile v2 が含まれています。OpenShift Dev Spaces デプロイメントでは、devfile-registry デプロイメントで 1 つの devfile レジストリーインスタンスを起動します。

図1.5 他のコンポーネントとの相互作用を登録する Devfile

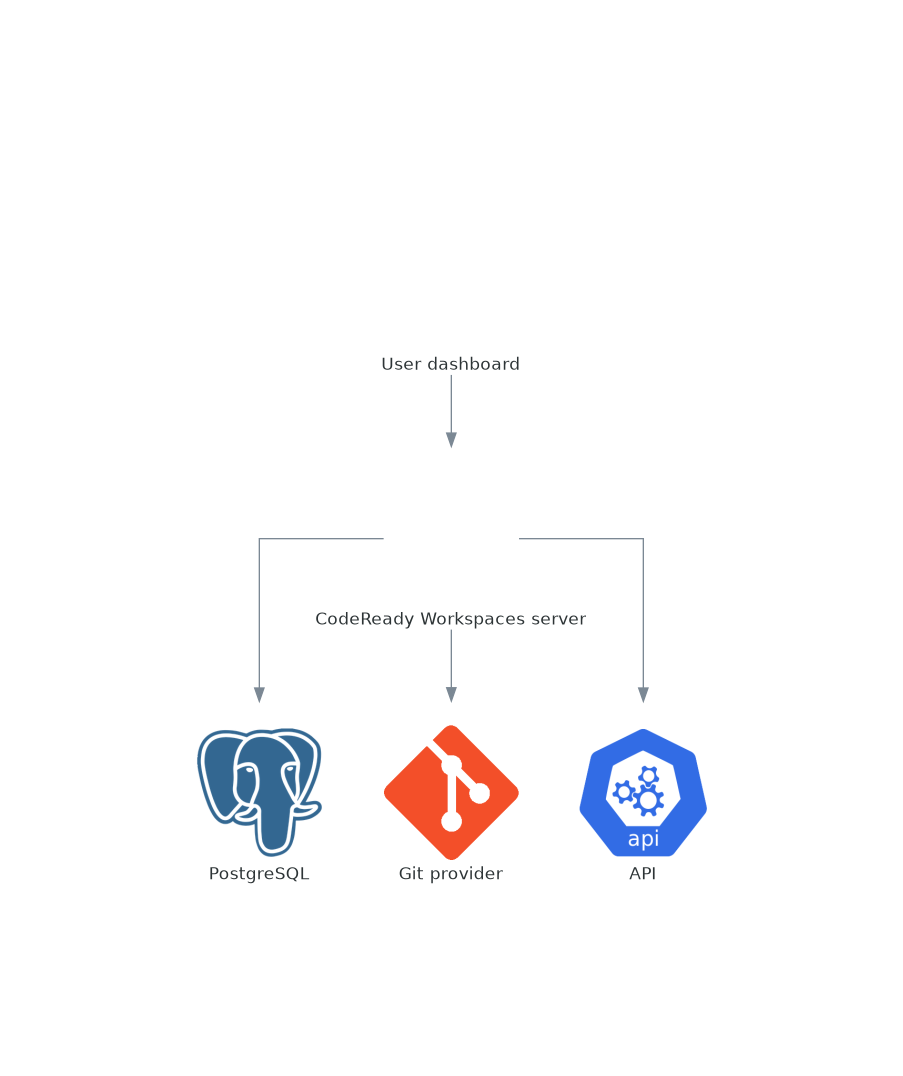

1.2.1.6. OpenShift Dev Spaces サーバー

OpenShift Dev Spaces サーバーの主な機能は次のとおりです。

- ユーザーネームスペースの作成

- ユーザーネームスペースに必要なシークレットと設定マップのプロビジョニング

- Git サービスプロバイダーとの統合による devfile の取得および認証

OpenShift Dev Spaces サーバーは、HTTP REST API を公開する Java Web サービスで、以下へのアクセスが必要です。

- 「PostgreSQL」

- Git サービスプロバイダー

- OpenShift API

図1.6 OpenShift Dev Spaces サーバーと他のコンポーネントとの対話

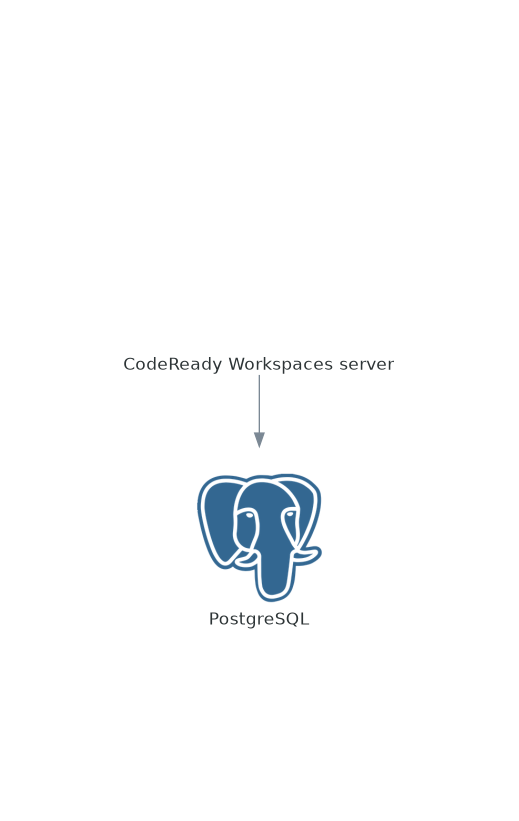

1.2.1.7. PostgreSQL

OpenShift Dev Spaces サーバーは、PostgreSQL データベースを使用してワークスペースのメタデータなどのユーザー設定を永続化します。

OpenShift Dev Spaces デプロイメントでは、postgres Deployment で専用の PostgreSQL インスタンスを起動します。代わりに外部データベースを使用することができます。

図1.7 Postgre SQL と他のコンポーネントとの対話

1.2.1.8. プラグインレジストリー

各 OpenShift Dev Spaces ワークスペースは、特定のエディターおよび関連する拡張機能のセットで始まります。OpenShift Dev Spaces プラグインレジストリーは、利用可能なエディターおよびエディターエクステンションの一覧を提供します。各エディターや拡張機能については、Devfile v2 に記載されています。

「ユーザーダッシュボード」 は、レジストリーの内容を読み取っています。

図1.8 プラグインは、他のコンポーネントとの相互作用を登録します。

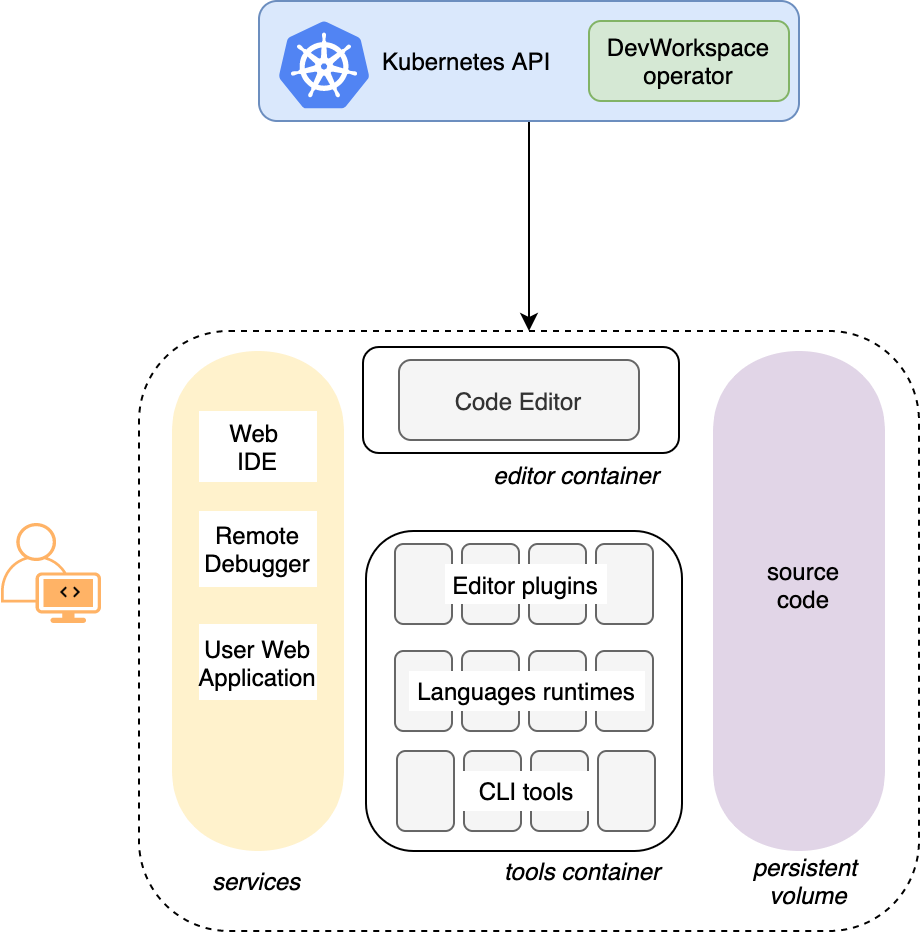

1.2.2. User ワークスペース

図1.9 User ワークスペースと他のコンポーネントとの対話

User ワークスペースは、コンテナー内で動作する Web IDE です。

User ワークスペースは、Web アプリケーションです。コンテナー内で動作するマイクロサービスで構成されており、ブラウザー上で動作する最新の IDE のすべてのサービスを提供します。

- エディター

- 言語オートコンプリート

- 言語サーバー

- デバッグツール

- プラグイン

- アプリケーションのランタイム

ワークスペースは、ワークスペースコンテナーと有効なプラグイン、および関連する OpenShift コンポーネントを含む 1 つの OpenShift Deployment です。

- コンテナー

- ConfigMap

- サービス

- エンドポイント

- ingress またはルート

- シークレット

- 永続ボリューム (PV)

OpenShift Dev Spaces ワークスペースには、OpenShift 永続ボリューム (PV) で永続化されるプロジェクトのソースコードが含まれます。マイクロサービスは、この共有ディレクトリーに読み書き可能なアクセス権があります。

devfile v2 形式を使用して、OpenShift Dev Spaces ワークスペースのツールおよびランタイムアプリケーションを指定します。

以下の図は、OpenShift Dev Spaces ワークスペースとそのコンポーネントを実行する 1 つを示しています。

図1.10 OpenShift Dev Spaces ワークスペースコンポーネント

この図では、実行中のワークスペースが 1 つあります。

1.3. OpenShift Dev Spaces リソース要件の計算

OpenShift Dev Spaces Operator、DevWorkspace Controller、およびユーザーワークスペースは Pod のセットで構成されます。これらの Pod は、CPU および RAM の制限および要求の点でリソース消費に貢献します。Red Hat OpenShift Dev Spaces の実行に必要なメモリーや CPU などのリソースを計算する方法を説明します。

1.3.1. OpenShift Dev Spaces Operator の要件

OpenShift Dev Spaces Operator は、6 つの異なる Pod で実行される 6 つのオペランドを管理します。以下の表は、これらのオペランドのデフォルトのリソース要件を示しています。

| Pod | コンテナー名 | デフォルトのメモリー制限 | デフォルトのメモリー要求 |

|---|---|---|---|

| OpenShift Dev Spaces Server | OpenShift Dev Spaces | 1 Gi | 512 MiB |

| OpenShift Dev Spaces Gateway |

| 4 Gi、256Mi、512Mi、512Mi | 128 Mi、64Mi、64Mi、64Mi |

| OpenShift Dev Spaces Dashboard |

| 256 Mi | 32 Mi |

| PostgreSQL |

| 1 Gi | 512 Mi |

| devfile レジストリー |

| 256 Mi | 32 Mi |

| プラグインレジストリー |

| 256 Mi | 32 Mi |

すべてのオペランドを有効にする OpenShift Dev Spaces Operator は、64Mi メモリー要求と 256Mi 制限を持つ単一コンテナーで構成されます。これらのデフォルト値は、OpenShift Dev Spaces Operator が比較的大量の OpenShift Dev Spaces ワークスペースを管理する場合に十分です。大規模なデプロイメントでは、デフォルト値を増やすことを検討してください。

1.3.2. DevWorkspace Operator の要件

DevWorkspace Operator は 3 つの Pod で構成されます。以下の表は、これらの各 Pod のデフォルトのリソース要件を示しています。

| Pod | コンテナー名 | デフォルトのメモリー制限 | デフォルトのメモリー要求 |

|---|---|---|---|

| DevWorkspace Controller Manager |

| 1 Gi | 100 Mi |

| DevWorkspace Operator Catalog |

| 該当なし | 50 Mi |

| DevWorkspace Webhook Server |

| 300 Mi | 20 Mi |

これらのデフォルト値は、DevWorkspace Controller が比較的大量の OpenShift DevSpaces ワークスペースを管理する場合に十分です。大規模なデプロイメントでは、デフォルト値を増やすことを検討してください。

1.3.3. ワークスペースの要件

本セクションでは、ワークスペースに必要なリソースを計算する方法を説明します。これは、ワークスペースの各コンテナーに必要なリソースの合計です。

手順

-

devfile の components セクションに明示的に指定されるワークスペース

componentsを特定します。 - 暗黙的なワークスペースコンポーネントを特定します。

OpenShift Dev Spaces は、デフォルトの theia-ide、che-machine-exec、che-gateway コンテナーを暗黙的に読み込みます。

- 各コンポーネントの要件を計算します。

1.3.4. ワークスペースの例

このセクションでは、OpenShift Dev Spaces ワークスペースの例について説明します。

以下の devfile は、OpenShift Dev Spaces ワークスペースを定義します。

この表は、各ワークスペースコンポーネントのメモリー要件を示しています。

| Pod | コンテナー名 | デフォルトのメモリー制限 | デフォルトのメモリー要求 |

|---|---|---|---|

| ワークスペース |

| 512 Mi | 64 Mi |

| ワークスペース |

| 128 Mi | 32 Mi |

| ワークスペース |

| 4 Gi | 64 Mi |

| ワークスペース |

| 256 Mi | 64 Mi |

| 合計 | 4.9 Gi | 224 Mi | |

第2章 OpenShift Dev Space のインストール

このセクションでは、Red Hat OpenShift Dev Spaces をインストールする手順を説明します。

OpenShift Dev Spaces のインスタンスは、クラスターごとに 1 つだけデプロイできます。

2.1. dsc 管理ツールのインストール

Red Hat OpenShift Dev Spaces コマンドライン管理ツールである dsc は、Microsoft Windows、Apple MacOS、および Linux にインストールできます。dsc を使用すると、サーバーの起動、停止、更新、削除など、OpenShift Dev Spaces サーバーの操作を実行できます。

手順

- https://developers.redhat.com/products/openshift-dev-spaces/download に移動し、バージョン 3.0 の OpenShift Dev Spaces CLI 管理ツールアーカイブをダウンロードします。

-

$HOME/dscなどのフォルダーにアーカイブを展開します。 展開したフォルダーから

dsc実行可能ファイルを実行します。以下に例を示します。$HOME/dsc/bin/dsc

$ $HOME/dsc/bin/dscCopy to Clipboard Copied! Toggle word wrap Toggle overflow 必要に応じて、完全パスの指定なしで

dscの実行を有効にするには、展開したbinディレクトリーを$PATHに追加します。以下に例を示します。PATH=$PATH:$HOME/dsc/bin

PATH=$PATH:$HOME/dsc/binCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証手順

ツールの現行バージョンを表示します。

dsc version

$ dsc versionCopy to Clipboard Copied! Toggle word wrap Toggle overflow

関連情報

2.2. dsc 管理ツールを使用した OpenShift への OpenShift Dev Spaces のインストール

OpenShift Dev Spaces を OpenShift にインストールできます。

前提条件

-

OpenShift クラスターへの管理権限を持つアクティブな

ocセッション。Getting started with the OpenShift CLI を参照してください。 -

dsc。「dsc 管理ツールのインストール」 を参照してください。

手順

OpenShift Dev Spaces インスタンスを作成します。

dsc server:deploy --platform openshift

$ dsc server:deploy --platform openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証手順

OpenShift Dev Spaces インスタンスのステータスを確認します。

dsc server:status

$ dsc server:statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Dev Spaces クラスターインスタンスに移動します。

dsc dashboard:open

$ dsc dashboard:openCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. Web コンソールを使用した OpenShift への OpenShift Dev Spaces のインストール

このセクションでは、OpenShift Web コンソールを使用して OpenShift Dev Spaces をインストールする方法について説明します。代わりに 「dsc 管理ツールを使用した OpenShift への OpenShift Dev Spaces のインストール」 を検討してください。

前提条件

- クラスター管理者による OpenShift Web コンソールセッション。Accessing the web console を参照してください。

手順

- Red Hat OpenShift Dev Spaces Operator をインストールします。Installing from OperatorHub using the web console を参照してください。

- Red Hat OpenShift Dev Spaces Operator から Create a OpenShift Dev Spaces インスタンスを作成します。Creating applications from installed Operators を参照してください。

検証

- OpenShift Dev Spaces インスタンスが正しくインストールされていることを確認するには、Operator detail ページの Dev Spaces Cluster タブに移動します。Red Hat OpenShift Dev Spaces インスタンス仕様 ページには、Red Hat OpenShift Dev Spaces インスタンスとそのステータスのリストが表示されます。

-

devspaces

CheClusterをクリックして、Details タブに移動します。 以下のフィールドの内容を参照してください。

-

Message フィールドにはエラーメッセージが含まれます。予想される内容は

Noneです。 - Red Hat OpenShift Dev Spaces URL フィールドには、Red Hat OpenShift Dev Spaces インスタンスの URL が含まれます。デプロイメントが正常に終了すると、URL が表示されます。

-

Message フィールドにはエラーメッセージが含まれます。予想される内容は

- Resources タブに移動します。OpenShift Dev Spaces デプロイメントに割り当てられたリソースの一覧とそのステータスを表示します。

2.4. OpenShift の制限された環境での OpenShift Dev Space のインストール

制限されたネットワークで動作する OpenShift クラスターでは、パブリックリソースは利用できません。

ただし、OpenShift Dev Spaces をデプロイしてワークスペースを実行するには、以下のパブリックリソースが必要です。

- Operator カタログ

- コンテナーイメージ

- サンプルプロジェクト

これらのリソースを使用可能にするには、OpenShift クラスターからアクセス可能なレジストリー内のそれらのコピーに置き換えます。

前提条件

- OpenShift クラスターに、少なくとも 64 GB のディスクスペースがある。

- OpenShift クラスターは制限されたネットワーク上で動作する準備ができており、OpenShift コントロールプレーンはパブリックインターネットにアクセスできる。非接続インストールのミラーリングについて、および ネットワークが制限された環境での Operator Lifecycle Manager の使用 を参照してください。

-

OpenShift クラスターへの管理権限を持つアクティブな

ocセッション。Getting started with the OpenShift CLI を参照してください。 -

registry.redhat.ioRed Hat エコシステムカタログへのアクティブなocレジストリーセッション。Red Hat Container Registry authentication を参照してください。

-

opm。Installing theopmCLI を参照してください。 -

jq。Downloadingjqを参照してください。 -

podman。Installing Podman を参照してください。 -

<my_registry> レジストリーへの管理アクセス権を持つアクティブな

skopeoセッション。Installing Skopeo, Authenticating to a registry および Mirroring images for a disconnected installation を参照してください。 -

OpenShift Dev Spaces バージョン 3.0 の

dsc。「dsc 管理ツールのインストール」 を参照してください。

手順

ミラーリングスクリプトをダウンロードして実行し、カスタム Operator カタログをインストールして、関連するイメージをミラーリングします: prepare-restricted-environment.sh。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 前の手順で

で che-operator-cr-patch.yamlに指定した設定で OpenShift Dev Spaces をインストールします。dsc server:deploy --platform=openshift \ --che-operator-cr-patch-yaml=che-operator-cr-patch.yaml

$ dsc server:deploy --platform=openshift \ --che-operator-cr-patch-yaml=che-operator-cr-patch.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第3章 OpenShift Dev Space の設定

このセクションでは、Red Hat OpenShift Dev Spaces の設定方法とオプションについて説明します。

3.1. CheCluster カスタムリソースについて

OpenShift Dev Spaces のデフォルトデプロイメントは、Red Hat OpenShift Dev Spaces Operator で定義される CheCluster カスタムリソースパラメーターで構成されます。

CheCluster カスタムリソースは Kubernetes オブジェクトです。CheCluster カスタムリソース YAML ファイルを編集して設定できます。このファイルには、各コンポーネントを設定するセクション(auth、database、server、storage)が含まれます。

Red Hat OpenShift Dev Spaces Operator は、CheCluster カスタムリソースを OpenShift Dev Spaces インストールの各コンポーネントで使用できる設定マップに変換します。

OpenShift プラットフォームは、設定を各コンポーネントに適用し、必要な Pod を作成します。OpenShift がコンポーネントの設定で変更を検知すると、Pod を適宜再起動します。

例3.1 OpenShift Dev Spaces サーバーコンポーネントの主なプロパティーの設定

-

serverコンポーネントセクションで適切な変更を加えたCheClusterカスタムリソース YAML ファイルを適用します。 -

Operator は、

cheConfigMapを生成します。 -

OpenShift は

ConfigMapの変更を検出し、OpenShift Dev Spaces Pod の再起動をトリガーします。

3.1.1. dsc を使用したインストール時に CheCluster カスタムリソースの設定

適切な設定で OpenShift Dev Space をデプロイするには、OpenShift Dev Space のインストール時に CheCluster カスタムリソース YAML ファイルを編集します。それ以外の場合は、OpenShift Dev Spaces デプロイメントは Operator で設定されたデフォルト設定パラメーターを使用します。

前提条件

-

OpenShift クラスターへの管理権限を持つアクティブな

ocセッション。Getting started with the OpenShift CLI を参照してください。 -

dsc。「dsc 管理ツールのインストール」 を参照してください。

手順

設定する

CheClusterカスタムリソースのサブセットを含むche-operator-cr-patch.yamlYAML ファイルを作成します。spec: <component>: <property-to-configure>: <value>spec: <component>: <property-to-configure>: <value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Dev Spaces をデプロイし、

che-operator-cr-patch.yamlファイルで説明されている変更を適用します。dsc server:deploy \ --che-operator-cr-patch-yaml=che-operator-cr-patch.yaml \ --platform <chosen-platform>

$ dsc server:deploy \ --che-operator-cr-patch-yaml=che-operator-cr-patch.yaml \ --platform <chosen-platform>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

設定されたプロパティーの値を確認します。

oc get configmap che -o jsonpath='{.data.<configured-property>}' \ -n openshift-devspaces$ oc get configmap che -o jsonpath='{.data.<configured-property>}' \ -n openshift-devspacesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.1.2. CLI を使用して CheCluster カスタムリソースの設定

OpenShift Dev Spaces の実行中のインスタンスを設定するには、CheCluster カスタムリソース YAML ファイルを編集します。

前提条件

- OpenShift 上の OpenShift Dev Spaces のインスタンス。

-

宛先 OpenShift クラスターへの管理権限を持つアクティブな

ocセッション。Getting started with the CLI を参照。

手順

クラスター上の CheCluster カスタムリソースを編集します。

oc edit checluster/devspaces -n openshift-devspaces

$ oc edit checluster/devspaces -n openshift-devspacesCopy to Clipboard Copied! Toggle word wrap Toggle overflow - ファイルを保存して閉じ、変更を適用します。

検証

設定されたプロパティーの値を確認します。

oc get configmap che -o jsonpath='{.data.<configured-property>}' \ -n openshift-devspaces$ oc get configmap che -o jsonpath='{.data.<configured-property>}' \ -n openshift-devspacesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.1.3. CheCluster カスタムリソースフィールドの参照

このセクションでは、CheCluster カスタムリソースのカスタマイズに使用できるすべてのフィールドについて説明します。

-

例3.2「最小の

CheClusterカスタムリソースの例。」 -

表3.1「OpenShift Dev Spaces

serverコンポーネントに関連するCheClusterカスタムリソースサーバー設定。」 -

表3.2「

OpenShift Dev Spacesで使用されるデータベースに関連する CheCluster カスタムリソースdatabase設定。」 -

表3.3「OpenShift Dev Spaces で使用される認証に関連するカスタムリソース

auth設定。」 -

表3.4「

OpenShift Dev Spacesで使用される永続ストレージに関連する CheCluster カスタムリソースstorage設定設定。」 -

表3.5「OpenShift での OpenShift Dev Spaces インストールに固有の

CheClusterカスタムリソースk8s設定。」 -

表3.6「OpenShift Dev Spaces で使用される OpenShift Dev Spaces メトリクスコレクションに関連する

CheClusterカスタムリソースmetrics設定。」 -

表3.7「

CheClusterカスタムリソースのstatusが OpenShift Dev Spaces インストールの観察される状態を定義します。」

例3.2 最小の CheCluster カスタムリソースの例。

| プロパティー | 説明 |

|---|---|

| airGapContainerRegistryHostname | イメージのプルに使用する別のコンテナーレジストリーに対する、オプションのホスト名または URL。この値は、Che デプロイメントに関連するすべてのデフォルトコンテナーイメージで定義されるコンテナーレジストリーのホスト名を上書きします。これは、制限された環境で Che をインストールする場合にとくに便利です。 |

| airGapContainerRegistryOrganization | イメージのプルに使用する別のコンテナーレジストリーのオプションのリポジトリー名。この値は、Che デプロイメントに関連するすべてのデフォルトコンテナーイメージで定義されるコンテナーレジストリーの組織を上書きします。これは、制限された環境で OpenShift Dev Spaces をインストールする場合にとくに役立ちます。 |

| allowUserDefinedWorkspaceNamespaces |

非推奨。このフラグの値は無視されます。ユーザーが Kubernetes namespace またはデフォルトとは異なる OpenShift プロジェクトを指定できるように定義します。OpenShift OAuth を設定せずに |

| cheClusterRoles |

Che ServiceAccount に割り当てられる ClusterRole のコンマ区切りの一覧。各ロールには、 |

| cheDebug |

Che サーバーのデバッグモードを有効にします。デフォルトは |

| cheFlavor |

非推奨。このフラグの値は無視されます。インストールのバリエーションを指定します。オプションは、アップストリーム Che インストールの場合は |

| cheHost |

インストールされた Che サーバーのパブリックホスト名。値を省略すると、値は Operator によって自動的に設定されます。 |

| cheHostTLSSecret |

インストールされた Che サーバーのカスタムホスト名の Ingress またはルートのセキュリティーを保護するための証明書が含まれるシークレットの名前。シークレットには、 |

| cheImage | Che デプロイメントで使用されるコンテナーイメージを上書きします。これには、コンテナーイメージタグは含まれません。Operator によって提供されるデフォルトのコンテナーイメージを使用するには、これを省略するか、または空のままにします。 |

| cheImagePullPolicy |

Che デプロイメントで使用されるイメージプルポリシーを上書きします。デフォルト値は、 |

| cheImageTag | Che デプロイメントで使用されるコンテナーイメージのタグを上書きします。Operator によって提供されるデフォルトのイメージタグを使用するには、これを省略するか、または空のままにします。 |

| cheLogLevel |

Che サーバーのログレベル: |

| cheServerIngress | Che サーバー Ingress のカスタム設定。 |

| cheServerRoute | Che サーバールートのカスタム設定。 |

| cheWorkspaceClusterRole |

Che ワークスペースのユーザーにバインドされるカスタムロール。ロールには、 |

| customCheProperties |

|

| dashboardCpuLimit | ダッシュボードのデプロイメントで使用される CPU 制限を上書きします。コア(500m = .5 コア)。デフォルトは 500m に設定されます。 |

| dashboardCpuRequest | ダッシュボードのデプロイメントで使用される CPU 要求を上書きします。コア(500m = .5 コア)。デフォルトは 100m に設定されます。 |

| dashboardImage | ダッシュボードのデプロイメントで使用されるコンテナーイメージを上書きします。これには、イメージタグが含まれます。Operator によって提供されるデフォルトのコンテナーイメージを使用するには、これを省略するか、または空のままにします。 |

| dashboardImagePullPolicy |

ダッシュボードのデプロイメントで使用されるイメージプルポリシーを上書きします。デフォルト値は、 |

| dashboardIngress | 非推奨。このフラグの値は無視されます。ダッシュボード Ingress のカスタム設定。 |

| dashboardMemoryLimit | ダッシュボードのデプロイメントで使用されるメモリー制限を上書きします。デフォルトは 256Mi に設定されます。 |

| dashboardMemoryRequest | ダッシュボードのデプロイメントで使用されるメモリー要求を上書きします。デフォルトは 16Mi に設定されます。 |

| dashboardRoute | 非推奨。このフラグの値は無視されます。ダッシュボードルートのカスタム設定。 |

| devfileRegistryCpuLimit | devfile レジストリーのデプロイメントで使用される CPU 制限を上書きします。コア(500m = .5 コア)。デフォルトは 500m に設定されます。 |

| devfileRegistryCpuRequest | devfile レジストリーのデプロイメントで使用される CPU 要求を上書きします。コア(500m = .5 コア)。デフォルトは 100m に設定されます。 |

| devfileRegistryImage | devfile レジストリーのデプロイメントで使用されるコンテナーイメージを上書きします。これには、イメージタグが含まれます。Operator によって提供されるデフォルトのコンテナーイメージを使用するには、これを省略するか、または空のままにします。 |

| devfileRegistryIngress | 非推奨。このフラグの値は無視されます。devfile レジストリー Ingress のカスタム設定。 |

| devfileRegistryMemoryLimit | devfile レジストリーのデプロイメントで使用されるメモリー制限を上書きします。デフォルトは 256Mi に設定されます。 |

| devfileRegistryMemoryRequest | devfile レジストリーのデプロイメントで使用されるメモリー要求を上書きします。デフォルトは 16Mi に設定されます。 |

| devfileRegistryPullPolicy |

devfile レジストリーのデプロイメントで使用されるイメージプルポリシーを上書きします。デフォルト値は、 |

| devfileRegistryRoute | 非推奨。このフラグの値は無視されます。devfile レジストリールートのカスタム設定。 |

| devfileRegistryUrl |

|

| disableInternalClusterSVCNames | 非推奨。このフラグの値は無視されます。内部クラスターの SVC 名の使用を無効にして、トラフィックを高速化し、プロキシーの問題を回避します。 |

| externalDevfileRegistries |

外部 devfile レジストリーで、すぐに使用可能な devfiles を提供します。( |

| externalDevfileRegistry |

専用の devfile レジストリーサーバーをデプロイするかどうかについて Operator に指示します。デフォルトでは、専用の devfile レジストリーサーバーが起動します。 |

| externalPluginRegistry |

専用のプラグインレジストリーサーバーをデプロイするかどうかについて Operator に指示します。デフォルトでは、専用のプラグインレジストリーサーバーが起動します。 |

| gitSelfSignedCert |

|

| nonProxyHosts |

プロキシーをバイパスして、直接到達されるホストの一覧。ワイルドカードのドメインを指定するには、以下の |

| pluginRegistryCpuLimit | プラグインレジストリーのデプロイメントで使用される CPU 制限を上書きします。コア(500m = .5 コア)。デフォルトは 500m に設定されます。 |

| pluginRegistryCpuRequest | プラグインレジストリーのデプロイメントで使用される CPU 要求を上書きします。コア(500m = .5 コア)。デフォルトは 100m に設定されます。 |

| pluginRegistryImage | プラグインレジストリーのデプロイメントで使用されるコンテナーイメージを上書きします。これには、イメージタグが含まれます。Operator によって提供されるデフォルトのコンテナーイメージを使用するには、これを省略するか、または空のままにします。 |

| pluginRegistryIngress | 非推奨。このフラグの値は無視されます。プラグインレジストリー Ingress のカスタム設定。 |

| pluginRegistryMemoryLimit | プラグインレジストリーのデプロイメントで使用されるメモリー制限を上書きします。デフォルトは 256Mi に設定されます。 |

| pluginRegistryMemoryRequest | プラグインレジストリーのデプロイメントで使用されるメモリー要求を上書きします。デフォルトは 16Mi に設定されます。 |

| pluginRegistryPullPolicy |

プラグインレジストリーのデプロイメントで使用されるイメージプルポリシーを上書きします。デフォルト値は、 |

| pluginRegistryRoute | 非推奨。このフラグの値は無視されます。プラグインレジストリールートのカスタム設定。 |

| pluginRegistryUrl |

サンプルのすぐに使できる devfile を提供するプラグインレジストリーの公開 URL。外部 devfile レジストリーを使用する必要がある場合は、この ONLY を設定します。 |

| proxyPassword |

プロキシーサーバーのパスワード。プロキシー設定が必要である場合にのみ使用します。 |

| proxyPort |

プロキシーサーバーのポート。プロキシーの設定が必要な場合にのみ使用します。 |

| proxySecret |

プロキシーサーバーの |

| proxyURL |

プロキシーサーバーの URL (プロトコル+ホスト名)。これにより、Che サーバーおよびワークスペースコンテナーの |

| proxyUser |

プロキシーサーバーのユーザー名。プロキシーの設定が必要な場合にのみ使用します。 |

| selfSignedCert | 非推奨。このフラグの値は無視されます。Che Operator は、ルーター証明書が自己署名されているかどうかを自動的に検知し、これを Che サーバーなどの他のコンポーネントに伝播します。 |

| serverCpuLimit | Che サーバーのデプロイメントで使用される CPU 制限を上書きします (コア単位)。(500m = .5 コア)。デフォルトは 1 に設定されます。 |

| serverCpuRequest | Che サーバーのデプロイメントで使用される CPU 要求を上書きします (コア単位)。(500m = .5 コア)。デフォルトは 100m に設定されます。 |

| serverExposureStrategy |

非推奨。このフラグの値は無視されます。サーバーおよびワークスペースの公開タイプを設定します。設定可能な値は、 |

| serverMemoryLimit | Che サーバーのデプロイメントで使用されるメモリー制限を上書きします。デフォルトは 1Gi に設定されます。 |

| serverMemoryRequest | Che サーバーのデプロイメントで使用されるメモリー要求を上書きします。デフォルトは 512Mi に設定されます。 |

| serverTrustStoreConfigMapName |

Che サーバーの Java トラストストアに追加するパブリック証明書のある ConfigMap の名前。これは、HTTPS エンドポイントが自己署の証明書で署名されている OpenShift OAuth プロバイダーを追加する際に必要になります。Che サーバーは、要求できるように CA 証明書を認識できる必要があります。これはデフォルトで無効にされます。Config Map には、 |

| singleHostGatewayConfigMapLabels | ゲートウェイ設定を表す ConfigMap に存在する必要があるラベル。 |

| singleHostGatewayConfigSidecarImage | ゲートウェイに設定を提供するゲートウェイサイドカーに使用されるイメージ。Operator によって提供されるデフォルトのコンテナーイメージを使用するには、これを省略するか、または空のままにします。 |

| singleHostGatewayImage | 単一ホストモードでゲートウェイに使用されるイメージ。Operator によって提供されるデフォルトのコンテナーイメージを使用するには、これを省略するか、または空のままにします。 |

| tlsSupport | 非推奨。Operator に対して Che を TLS モードでデプロイするように指示します。これはデフォルトで有効になっています。TLS を無効にすると、Che コンポーネントが正しく機能しないことがあります。 |

| useInternalClusterSVCNames |

|

| workspaceNamespaceDefault |

ユーザーが上書きしない場合にユーザーのワークスペースが作成される Kubernetes のデフォルト namespace を定義します。 |

| workspacePodNodeSelector | ワークスペース Pod を実行できるノードを制限するノードセレクター。 |

| workspacePodTolerations | ワークスペース Pod を実行できる場所を制限するために、ワークスペース Pod に適用される Pod 許容値。 |

| workspacesDefaultPlugins | Devworkspaces に適用されるデフォルトのプラグイン。 |

| プロパティー | 説明 |

|---|---|

| chePostgresContainerResources | PostgreSQL コンテナーのカスタム設定 |

| chePostgresDb |

Che サーバーが DB への接続に使用する PostgreSQL データベース名。デフォルトは |

| chePostgresHostName |

Che サーバーが接続する PostgreSQL データベースのホスト名。デフォルトは |

| chePostgresPassword | Che サーバーが DB への接続に使用する PostgreSQL パスワード。これは、省略されるか、または空のままの場合は、自動的に生成される値に設定されます。 |

| chePostgresPort |

Che サーバーが接続する PostgreSQL データベースのポート。デフォルトは 5432 に設定されます。外部データベースを使用する場合、この値のみを上書きします。 |

| chePostgresSecret |

Che サーバーが DB への接続に使用する PosgreSQL の `user` および |

| chePostgresUser |

Che サーバーが DB への接続に使用する PostgreSQL ユーザー。デフォルトは |

| externalDb |

専用のデータベースをデプロイするかどうかについて Operator に指示します。デフォルトでは、専用の PostgreSQL データベースは Che インストールの一部としてデプロイされます。 |

| postgresImage | PostgreSQL データベースのデプロイメントで使用されるコンテナーイメージを上書きします。これには、イメージタグが含まれます。Operator によって提供されるデフォルトのコンテナーイメージを使用するには、これを省略するか、または空のままにします。 |

| postgresImagePullPolicy |

PostgreSQL データベースのデプロイメントで使用されるイメージプルポリシーを上書きします。デフォルト値は、 |

| postgresVersion |

使用する Postgre SQL バージョンイメージを示します。使用できる値は |

| pvcClaimSize |

データベースの永続ボリュームクレームのサイズ。デフォルトは |

| プロパティー | 説明 |

|---|---|

| debug | 非推奨。このフラグの値は無視されます。内部 ID プロバイダーをデバッグします。 |

| externalIdentityProvider |

非推奨。このフラグの値は無視されます。専用のアイデンティティープロバイダー (Keycloak または RH SSO インスタンス) をデプロイするかどうかについて Operator に指示します。専用のアイデンティティープロバイダー (Keycloak または RH-SSO インスタンス) をデプロイするかどうかについて Operator に指示します。デフォルトで、専用のアイデンティティープロバイダーサーバーは Che インストールの一部としてデプロイされます。 |

| gatewayAuthenticationSidecarImage | NativeUserMode が有効な場合に認証を行うゲートウェイサイドカー。oauth2-proxy または openshift/oauth-proxy を参照してください。 |

| gatewayAuthorizationSidecarImage | NativeUserMode が有効な場合に承認を行うゲートウェイサイドカー。kube-rbac-proxy または openshift/kube-rbac-proxyを参照してください。 |

| gatewayHeaderRewriteSidecarImage | 非推奨。このフラグの値は無視されます。サイドカー機能が Traefik プラグインに実装されるようになりました。 |

| identityProviderAdminUserName |

非推奨。このフラグの値は無視されます。アイデンティティープロバイダーの管理者ユーザーの名前を上書きします。デフォルトは |

| identityProviderClientId |

非推奨。このフラグの値は無視されます。Che に使用されるアイデンティティープロバイダー、Keycloak、または RH-SSO の |

| identityProviderContainerResources | 非推奨。このフラグの値は無視されます。アイデンティティープロバイダーコンテナーのカスタム設定。 |

| identityProviderImage | 非推奨。このフラグの値は無視されます。アイデンティティープロバイダー、Keycloak、または RH-SSO デプロイメントで使用するコンテナーイメージを上書きします。これには、イメージタグが含まれます。Operator によって提供されるデフォルトのコンテナーイメージを使用するには、これを省略するか、または空のままにします。 |

| identityProviderImagePullPolicy |

非推奨。このフラグの値は無視されます。アイデンティティープロバイダー、Keycloak、または RH-SSO デプロイメントで使用するイメージプルポリシーを上書きします。デフォルト値は、 |

| identityProviderIngress | 非推奨。このフラグの値は無視されます。Ingress のカスタム設定。 |

| identityProviderPassword |

非推奨。このフラグの値は無視されます。Keycloak 管理者ユーザーのパスワードを上書きします。外部アイデンティティープロバイダーが使用されている場合にこれを上書きします。 |

| identityProviderPostgresPassword |

非推奨。このフラグの値は無視されます。データベースに接続するために使用するアイデンティティープロバイダー、Keycloak、または RH-SSO のパスワード外部アイデンティティープロバイダーが使用されている場合にこれを上書きします。 |

| identityProviderPostgresSecret |

非推奨。このフラグの値は無視されます。データベースに接続するために使用するアイデンティティープロバイダー、Keycloak、または RH-SSO の |

| identityProviderRealm |

非推奨。このフラグの値は無視されます。Che に使用されるアイデンティティープロバイダー、Keycloak、または RH-SSO のレルムの名前。外部アイデンティティープロバイダーが使用されている場合にこれを上書きします。 |

| identityProviderRoute | 非推奨。このフラグの値は無視されます。ルートのカスタム設定。 |

| identityProviderSecret |

非推奨。このフラグの値は無視されます。アイデンティティープロバイダーの |

| identityProviderURL |

アイデンティティープロバイダーサーバー (Keycloak/RH-SSO サーバー) の公開 URL。外部アイデンティティープロバイダーを使用する必要がある場合は、これのみを設定します。 |

| initialOpenShiftOAuthUser |

非推奨。このフラグの値は無視されます。OpenShift OAuth 認証の操作には、kubeadmin を使用できないため、新規ユーザーアカウントを作成します。値が true の場合には、HTPasswd アイデンティティープロバイダーに新しい OpenShift OAuth ユーザーが作成されます。値が false で、ユーザーがすでに作成されている場合は、削除されます。値が空白の場合は何も実行されません。ユーザーの認証情報は、Operator によって 'openshift-config' namespace にある |

| nativeUserMode | 非推奨。このフラグの値は無視されます。ネイティブユーザーモードを有効にします。現在、OpenShift および DevWorkspace エンジンでのみ動作します。ネイティブユーザーモードは、Keycloak なしで OpenShift OAuth を直接アイデンティティープロバイダーとして使用します。 |

| oAuthClientName |

OpenShift 側でアイデンティティーフェデレーションを設定するために使用される OpenShift |

| oAuthSecret |

OpenShift 側でアイデンティティーフェデレーションを設定するために使用される OpenShift |

| openShiftoAuth |

非推奨。このフラグの値は無視されます。アイデンティティープロバイダー (Keycloak/RHSSO) と OpenShift OAuth の統合を有効にします。デフォルトでは OpenShift の値は空になります。これにより、ユーザーは OpenShift ログインで OpenShift ユーザーとして直接ログインでき、独自のワークスペースを個人の OpenShift namespace の下に作成できます。警告: |

| updateAdminPassword |

非推奨。このフラグの値は無視されます。デフォルトの |

| プロパティー | 説明 |

|---|---|

| postgresPVCStorageClassName | PostgreSQL データベース専用の Persistent Volume Claim (永続ボリューム要求、PVC) のストレージクラス。省略されるか、または空のままの場合は、デフォルトのストレージクラスが使用されます。 |

| preCreateSubPaths |

Che サーバーに対し、永続ボリュームでサブパスを事前に作成するために特別な Pod を起動するように指示します。デフォルトは |

| pvcClaimSize |

ワークスペースの永続ボリューム要求 (PVC) のサイズ。デフォルトは |

| pvcJobsImage |

永続ボリュームでサブパスを作成するために使用されるコンテナーイメージを上書きします。これには、イメージタグが含まれます。Operator によって提供されるデフォルトのコンテナーイメージを使用するには、これを省略するか、または空のままにします。 |

| pvcStrategy |

Che サーバーの永続ボリューム要求ストラテジー。これには、'common' (1 つのボリュームにすべてのワークスペース PVC)、 |

| workspacePVCStorageClassName | Che ワークスペース専用の Persistent Volume Claim(永続ボリューム要求、PVC)のストレージクラス。省略されるか、または空のままの場合は、デフォルトのストレージクラスが使用されます。 |

| プロパティー | 説明 |

|---|---|

| ingressClass |

Ingress を管理するコントローラーを定義する Ingress クラス。デフォルトは |

| ingressDomain | Kubernetes クラスターのグローバル Ingress ドメイン。これは明示的に指定する必要があります。デフォルト値はありません。 |

| ingressStrategy |

非推奨。このフラグの値は無視されます。Ingress 作成のストラテジー。オプション: |

| securityContextFsGroup |

Che Pod およびワークスペース Pod コンテナーが実行される FSGroup。デフォルト値は |

| securityContextRunAsUser |

Che Pod およびワークスペース Pod コンテナーの実行に使用するユーザーの ID。デフォルト値は |

| singleHostExposureType |

非推奨。このフラグの値は無視されます。serverExposureStrategy が |

| tlsSecretName |

TLS が有効にされている場合に ingress TLS 終端を設定するために使用されるシークレットの名前。フィールドが空の文字列である場合、デフォルトのクラスター証明書が使用されます。 |

| プロパティー | 説明 |

|---|---|

| enable |

Che サーバーエンドポイント |

| プロパティー | 説明 |

|---|---|

| cheClusterRunning |

Che インストールのステータス。 |

| cheURL | Che サーバーへの公開 URL。 |

| cheVersion | 現在のインストールされている Che バージョン。 |

| dbProvisioned | PostgreSQL インスタンスが正しくプロビジョニングされているかどうかを示します。 |

| devfileRegistryURL | devfile レジストリーへの公開 URL。 |

| devworkspaceStatus | Devworkspace サブシステムのステータス |

| gitHubOAuthProvisioned | アイデンティティープロバイダーインスタンス、Keycloak または RH-SSO が GitHub OAuth と統合するように設定されているかどうかを示します。 |

| helpLink | 現在の Operator ステータスに関連するヘルプの検索に使用する URL を参照する URL。 |

| keycloakProvisioned | アイデンティティープロバイダーインスタンス、Keycloak または RH-SSO がレルム、クライアント、およびユーザーと共にプロビジョニングされているかどうかを示します。 |

| keycloakURL | アイデンティティープロバイダーサーバー (Keycloak/RH-SSO) の公開 URL。 |

| message | Pod がこの状態にある理由の詳細を示す、人が判読できるメッセージ。 |

| openShiftOAuthUserCredentialsSecret |

HTPasswd アイデンティティープロバイダーのユーザー認証情報を含む |

| openShiftoAuthProvisioned | アイデンティティープロバイダーインスタンス、Keycloak または RH-SSO が OpenShift OAuth と統合するように設定されているかどうかを示します。 |

| pluginRegistryURL | プラグインレジストリーへの公開 URL。 |

| reason | Pod がこの状態にある理由の詳細を示す簡単な CamelCase メッセージ。 |

3.2. ユーザープロジェクトプロビジョニングの設定

OpenShift Dev Spaces は、ユーザーごとに、プロジェクト内のワークスペースを分離します。OpenShift Dev Spaces は、ラベルとアノテーションの存在によってユーザープロジェクトを識別します。ワークスペースを起動する際に必要なプロジェクトが存在しない場合、OpenShift Dev Spaces はテンプレート名を使用してプロジェクトを作成します。

OpenShift Dev Spaces の動作は、次の方法で変更できます。

3.2.1. 自動プロビジョニング用のユーザープロジェクト名の設定

OpenShift Dev Spaces がワークスペース起動時に必要なプロジェクトを作成するために使用するプロジェクト名テンプレートを設定できます。

有効なプロジェクト名テンプレートは、次の規則に従います。

-

<username>または<userid>プレースホルダーは必須です。 -

ユーザー名と ID に無効な文字を含めることはできません。ユーザー名または ID のフォーマットが OpenShift オブジェクトの命名規則と互換性がない場合、OpenShift Dev Spaces は、互換性のない文字を

-記号に置き換えてユーザー名や ID を有効な名前に変更します。 -

OpenShift Dev Spaces は、

<userid>プレースホルダーを 14 文字の文字列と判断し、ID が衝突しないようにランダムな 6 文字の接尾辞を追加します。結果は、再利用のためにユーザー設定に保存されます。 - Kubernetes は、プロジェクト名の長さを 63 文字に制限しています。

- OpenShift は、長さをさらに 49 文字に制限しています。

手順

CheClusterカスタムリソースを設定します。「CLI を使用して CheCluster カスタムリソースの設定」 を参照してください。spec: server: workspaceNamespaceDefault: <workspace_namespace_template_>spec: server: workspaceNamespaceDefault: <workspace_namespace_template_>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例3.3 ユーザーワークスペースプロジェクト名テンプレートの例

Expand ユーザーワークスペースプロジェクト名テンプレート 結果のプロジェクト例 <username>-devspaces(デフォルト)user1-devspaces

<userid>-namespacecge1egvsb2nhba-namespace-ul1411<userid>-aka-<username>-namespacecgezegvsb2nhba-aka-user1-namespace-6m2w2b

3.2.2. プロジェクトの事前プロビジョニング

自動プロビジョニングに依存するのではなく、ワークスペースプロジェクトを事前にプロビジョニングできます。ユーザーごとに手順を繰り返します。

手順

次のラベルとアノテーションを使用して、<username> ユーザーの <project_name> プロジェクトを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 選択したプロジェクト名を使用します。

3.3. サーバーコンポーネントの設定

3.3.1. シークレットまたは ConfigMap をファイルまたは環境変数として OpenShift Dev Spaces コンテナーにマウントする

シークレットは、以下のような機密データを格納する OpenShift オブジェクトです。

- ユーザー名

- パスワード

- 認証トークン

(暗号化された形式)。

ユーザーは、機密データまたは OpenShift Dev Spaces で管理されるコンテナーの設定が含まれる ConfigMap を以下のようにマウントできます。

- ファイル

- 環境変数

マウントプロセスでは、標準の OpenShift マウントメカニズムを使用しますが、追加のアノテーションとラベル付けが必要です。

3.3.1.1. シークレットまたは ConfigMap を OpenShift Dev Spaces コンテナーにファイルとしてマウントする

前提条件

- Red Hat OpenShift Dev Spaces の実行中のインスタンス

手順

OpenShift Dev Spaces がデプロイされている OpenShift プロジェクトに新しい OpenShift シークレットまたは ConfigMap を作成します。作成される予定のオブジェクトのラベルは、ラベルのセットと一致する必要があります。

-

app.kubernetes.io/part-of: che.eclipse.org -

app.kubernetes.io/component: <DEPLOYMENT_NAME>-<OBJECT_KIND> <DEPLOYMENT_NAME>には、以下のデプロイメントのいずれかを使用します。-

postgres -

keycloak -

devfile-registry -

plugin-registry devspacesおよび

-

<jasper_KIND>は以下のいずれかになります。secretまたは

-

configmap

-

例3.4 以下に例を示します。

または

アノテーションは、指定されるオブジェクトがファイルとしてマウントされていることを示す必要があります。

アノテーション値を設定します。

-

che.eclipse.org/mount-as: file- オブジェクトをファイルとしてマウントするように指定します。 -

che.eclipse.org/mount-path: <TARGET_PATH>- 必要なマウントパスを指定します。

-

例3.5 以下に例を示します。

または

OpenShift オブジェクトには複数の項目が含まれる可能性があり、その名前はコンテナーにマウントされる必要なファイル名と一致する必要があります。

例3.6 以下に例を示します。

または

これにより、ca.crt という名前のファイルが OpenShift Dev Spaces コンテナーの /data パスにマウントされます。

OpenShift Dev Spaces コンテナーに変更を加えるには、オブジェクトを完全に再作成します。

3.3.1.2. シークレットまたは ConfigMap を環境変数として OpenShift Dev Spaces コンテナーにマウントする

前提条件

- Red Hat OpenShift Dev Spaces の実行中のインスタンス

手順

OpenShift Dev Spaces がデプロイされている OpenShift プロジェクトに新しい OpenShift シークレットまたは ConfigMap を作成します。作成される予定のオブジェクトのラベルは、ラベルのセットと一致する必要があります。

-

app.kubernetes.io/part-of: che.eclipse.org -

app.kubernetes.io/component: <DEPLOYMENT_NAME>-<OBJECT_KIND> <DEPLOYMENT_NAME>には、以下のデプロイメントのいずれかを使用します。-

postgres -

keycloak -

devfile-registry -

plugin-registry devspacesおよび

-

<jasper_KIND>は以下のいずれかになります。secretまたは

-

configmap

-

例3.7 以下に例を示します。

または

アノテーションは、指定されるオブジェクトが環境変数としてマウントされていることを示す必要があります。

アノテーション値を設定します。

-

che.eclipse.org/mount-as: env-: オブジェクトを環境変数としてマウントするように指定します。 -

che.eclipse.org/env-name: <FOOO_ENV>: オブジェクトキー値のマウントに必要な環境変数名を指定します。

-

例3.8 以下に例を示します。

または

これにより、2 つの環境変数が

-

FOO_ENV -

myvalue

OpenShift Dev Spaces コンテナーにプロビジョニングされている。

オブジェクトに複数のデータ項目がある場合、環境変数の名前は以下のようにそれぞれのデータキーについて指定される必要があります。

例3.9 以下に例を示します。

または

これにより、2 つの環境変数が

-

FOO_ENV -

OTHER_ENV

OpenShift Dev Spaces コンテナーにプロビジョニングされている。

OpenShift シークレットのアノテーション名の最大長さは 63 文字です。ここで、9 文字は、/ で終わるプレフィックス用に予約されます。これは、オブジェクトに使用できるキーの最大長さの制限として機能します。

OpenShift Dev Spaces コンテナーに変更を加えるには、オブジェクトを完全に再作成します。

3.3.2. OpenShift Dev Spaces サーバーコンポーネントの詳細な設定オプション

以下のセクションでは、OpenShift Dev Spaces サーバーコンポーネントの詳細なデプロイメントおよび設定方法を説明します。

3.3.2.1. OpenShift Dev Spaces サーバーの詳細設定について

以下のセクションでは、OpenShift Dev Spaces サーバーコンポーネントの詳細設定方法について説明します。

詳細設定は以下を実行するために必要です。

-

標準の

CheClusterカスタムリソースフィールドから Operator によって自動的に生成されない環境変数を追加します。 -

標準の

CheClusterカスタムリソースフィールドから Operator によって自動的に生成されるプロパティーを上書きします。

CheCluster Custom Resource server 設定の一部である customCheProperties フィールドには、OpenShift Dev Spaces サーバーコンポーネントに適用する追加の環境変数のマップが含まれます。

例3.10 ワークスペースのデフォルトのメモリー制限の上書き

CheClusterカスタムリソースを設定します。「CLI を使用して CheCluster カスタムリソースの設定」 を参照してください。spec: server: customCheProperties: CHE_WORKSPACE_DEFAULT__MEMORY__LIMIT__MB: "2048"spec: server: customCheProperties: CHE_WORKSPACE_DEFAULT__MEMORY__LIMIT__MB: "2048"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

OpenShift Dev Spaces Operator の以前のバージョンには、このロールを果たすために custom という名前の ConfigMap がありました。OpenShift Dev Spaces オペレーターが custom という名前の configMap を見つけると、それに含まれるデータを customCheProperties フィールドに追加し、OpenShift Dev Spaces を再デプロイして、カスタムconfigMap を削除します。

3.3.2.2. OpenShift Dev Spaces サーバーコンポーネントのシステムプロパティーの参照

以下のドキュメントでは、OpenShift Dev Spaces サーバーコンポーネントの可能な設定プロパティーをすべて説明します。

3.3.2.2.1. OpenShift Dev Spaces サーバー

3.3.2.2.1.1. CHE_API

API サービス。ブラウザーは、この URL を使用して OpenShift Dev Spaces サーバーへの REST 通信を開始します。

- デフォルト

-

http://${CHE_HOST}:${CHE_PORT}/api

3.3.2.2.1.2. CHE_API_INTERNAL

API サービスの内部ネットワーク URL。バックエンドサービスは、この URL を使用して OpenShift Dev Spaces サーバーへの REST 通信を開始する必要があります。

- デフォルト

-

NULL

3.3.2.2.1.3. CHE_WEBSOCKET_ENDPOINT

OpenShift Dev Spaces WebSocket の主なエンドポイント。主な websocket の対話とメッセージング用の基本的な通信エンドポイントを提供します。

- デフォルト

-

ws://${CHE_HOST}:${CHE_PORT}/api/websocket

3.3.2.2.1.4. CHE_WEBSOCKET_INTERNAL_ENDPOINT

OpenShift Dev Spaces WebSocket の主な内部エンドポイント。主な websocket の対話とメッセージング用の基本的な通信エンドポイントを提供します。

- デフォルト

-

NULL

3.3.2.2.1.5. CHE_WORKSPACE_PROJECTS_STORAGE

プロジェクトは、OpenShift Dev Spaces サーバーから、各ワークスペースを実行するマシンに同期されます。これは、プロジェクトが配置されているマシンのディレクトリーです。

- デフォルト

-

/projects

3.3.2.2.1.6. CHE_WORKSPACE_PROJECTS_STORAGE_DEFAULT_SIZE

devfile 要求の OpenShift タイプのコンポーネントがプロジェクト PVC 作成を要求する場合に使用されます (unique および 'per workspace PVC ストラテジーの場合に適用されます。common PVC ストラテジーの場合は、これは che.infra.kubernetes.pvc.quantity プロパティーの値で書き換えられます)。

- デフォルト

-

1Gi

3.3.2.2.1.7. CHE_WORKSPACE_LOGS_ROOT__DIR

すべてのワークスペースログが置かれるマシン内のディレクトリーを定義します。環境変数などの値として、この値をマシンに指定します。これは、エージェントの開発者がこのディレクトリーを使用してエージェントのログをバックアップできるようにするためのものです。

- デフォルト

-

/workspace_logs

3.3.2.2.1.8. CHE_WORKSPACE_HTTP__PROXY

環境変数 HTTP_PROXY は、ワークスペースを起動するコンテナーで指定された値に設定します。

- デフォルト

- empty

3.3.2.2.1.9. CHE_WORKSPACE_HTTPS__PROXY

環境変数 HTTPS_PROXY は、ワークスペースを起動するコンテナーで指定された値に設定します。

- デフォルト

- empty

3.3.2.2.1.10. CHE_WORKSPACE_NO__PROXY

環境変数 NO_PROXY は、ワークスペースを起動するコンテナーで指定された値に設定します。

- デフォルト

- empty

3.3.2.2.1.11. CHE_WORKSPACE_AUTO__START

デフォルトでは、ユーザーがこの URL を使用してワークスペースにアクセスすると、ワークスペースは自動的に起動します (現時点で停止している場合)。この動作を無効にするには、このパラメーターを false に設定します。

- デフォルト

-

true

3.3.2.2.1.12. CHE_WORKSPACE_POOL_TYPE

ワークスペーススレッドプールの設定。このプールは、非同期の実行が必要なワークスペース関連の操作 (例: 起動/停止) に使用されます。設定可能な値は fixed および cached です。

- デフォルト

-

固定:

3.3.2.2.1.13. CHE_WORKSPACE_POOL_EXACT__SIZE

プールタイプが fixed と異なる場合に、このプロパティーは無視されます。これはプールのサイズを設定します。設定されると、multiplier プロパティーは無視されます。このプロパティーが設定されていない場合 (0, <0, NULL)、プールサイズはコア数と等しくなります。che.workspace.pool.cores_multiplier も参照してください。

- デフォルト

-

30

3.3.2.2.1.14. CHE_WORKSPACE_POOL_CORES__MULTIPLIER

プールタイプが fixed に設定されておらず、che.workspace.pool.exact_size が設定されている場合は、このプロパティーは無視されます。設定されている場合、プールサイズは N_CORES * multiplier になります。

- デフォルト

-

2

3.3.2.2.1.15. CHE_WORKSPACE_PROBE__POOL__SIZE

このプロパティーは、ワークスペースサーバーの liveness プローブに使用するスレッドの数を指定します。

- デフォルト

-

10

3.3.2.2.1.16. CHE_WORKSPACE_HTTP__PROXY__JAVA__OPTIONS

ワークスペース JVM の HTTP プロキシー設定。

- デフォルト

-

NULL

3.3.2.2.1.17. CHE_WORKSPACE_JAVA__OPTIONS

ワークスペースで実行されている JVM に追加される Java コマンドラインオプション。

- デフォルト

-

-XX:MaxRAM=150m-XX:MaxRAMFraction=2 -XX:+UseParallelGC -XX:MinHeapFreeRatio=10 -XX:MaxHeapFreeRatio=20 -XX:GCTimeRatio=4 -XX:AdaptiveSizePolicyWeight=90 -Dsun.zip.disableMemoryMapping=true -Xms20m -Djava.security.egd=file:/dev/./urandom

3.3.2.2.1.18. CHE_WORKSPACE_MAVEN__OPTIONS

ワークスペースでエージェントを実行する JVM に追加される Maven コマンドラインオプション。

- デフォルト

-

-XX:MaxRAM=150m-XX:MaxRAMFraction=2 -XX:+UseParallelGC -XX:MinHeapFreeRatio=10 -XX:MaxHeapFreeRatio=20 -XX:GCTimeRatio=4 -XX:AdaptiveSizePolicyWeight=90 -Dsun.zip.disableMemoryMapping=true -Xms20m -Djava.security.egd=file:/dev/./urandom

3.3.2.2.1.19. CHE_WORKSPACE_DEFAULT__MEMORY__LIMIT__MB

環境に RAM 設定のない各マシンの RAM 制限のデフォルト。0 以下の値値は、制限を無効にするものとして解釈されます。

- デフォルト

-

1024

3.3.2.2.1.20. CHE_WORKSPACE_DEFAULT__MEMORY__REQUEST__MB

環境内に明示的な RAM 設定のない各コンテナーの RAM 要求。この量はワークスペースコンテナーの作成時に割り当てられます。このプロパティーは、すべてのインフラストラクチャー実装でサポートされる訳ではありません。現時点で、これは OpenShift によってサポートされます。メモリー制限を超えるメモリー要求は無視され、制限サイズのみが使用されます。0 以下の値値は、制限を無効にするものとして解釈されます。

- デフォルト

-

200

3.3.2.2.1.21. CHE_WORKSPACE_DEFAULT__CPU__LIMIT__CORES

環境に CPU 設定のない各コンテナーの CPU 制限。浮動小数点のコア数 (例: 0.125) で、または Kubernetes 形式 (125m などの整数のミリコア数) を使用して指定します。0 以下の値値は、制限を無効にするものとして解釈されます。

- デフォルト

-

-1

3.3.2.2.1.22. CHE_WORKSPACE_DEFAULT__CPU__REQUEST__CORES

環境内に CPU 設定のない各コンテナーの CPU 要求。CPU 制限を超える CPU 要求は無視され、制限の数値のみが使用されます。0 以下の値値は、制限を無効にするものとして解釈されます。

- デフォルト

-

-1

3.3.2.2.1.23. CHE_WORKSPACE_SIDECAR_DEFAULT__MEMORY__LIMIT__MB

OpenShift Dev Spaces プラグイン設定に RAM 設定のない各サイドカーの RAM 制限。0 以下の値値は、制限を無効にするものとして解釈されます。

- デフォルト

-

128

3.3.2.2.1.24. CHE_WORKSPACE_SIDECAR_DEFAULT__MEMORY__REQUEST__MB

OpenShift Dev Spaces プラグイン設定に RAM 設定のない各サイドカーの RAM 要求。

- デフォルト

-

64

3.3.2.2.1.25. CHE_WORKSPACE_SIDECAR_DEFAULT__CPU__LIMIT__CORES

OpenShift Dev Spaces プラグイン設定に CPU 設定のない各サイドカーの CPU 制限のデフォルト。浮動小数点のコア数 (例: 0.125) で、または Kubernetes 形式 (125m などの整数のミリコア数) を使用して指定します。0 以下の値値は、制限を無効にするものとして解釈されます。

- デフォルト

-

-1

3.3.2.2.1.26. CHE_WORKSPACE_SIDECAR_DEFAULT__CPU__REQUEST__CORES

OpenShift Dev Spaces プラグイン設定に CPU 設定のない各サイドカーの CPU 要求のデフォルト。浮動小数点のコア数 (例: 0.125) で、または Kubernetes 形式 (125m などの整数のミリコア数) を使用して指定します。

- デフォルト

-

-1

3.3.2.2.1.27. CHE_WORKSPACE_SIDECAR_IMAGE__PULL__POLICY

サイドカーのイメージプルストラテジーを定義します。使用できる値は Always、Never、IfNotPresent です。その他の値については、Always は :latest タグが付いたイメージに、その他の場合は IfNotPresent が想定されます。

- デフォルト

-

Always

3.3.2.2.1.28. CHE_WORKSPACE_ACTIVITY__CHECK__SCHEDULER__PERIOD__S

非アクティブなワークスペースの一時停止ジョブの実行期間。

- デフォルト

-

60

3.3.2.2.1.29. CHE_WORKSPACE_ACTIVITY__CLEANUP__SCHEDULER__PERIOD__S

アクティビティーテーブルのクリーンアップ期間。アクティビティーテーブルには、サーバーが特定の時点で障害が発生するなどの予想されないエラーが生じる場合に、無効なデータまたは古いデータを含まれることがあります。デフォルトでは、クリーンアップジョブは 1 時間ごとに実行されます。

- デフォルト

-

3600

3.3.2.2.1.30. CHE_WORKSPACE_ACTIVITY__CLEANUP__SCHEDULER__INITIAL__DELAY__S

サーバーの起動後から最初のアクティビティーのクリーンアップジョブを開始するまでの遅延。

- デフォルト

-

60

3.3.2.2.1.31. CHE_WORKSPACE_ACTIVITY__CHECK__SCHEDULER__DELAY__S

OpenShift Dev Spaces サーバーが非アクティブタイムアウトに近い期間利用できない場合に、マスカレードチェックジョブが開始されるまでの遅延。

- デフォルト

-

180

3.3.2.2.1.32. CHE_WORKSPACE_CLEANUP__TEMPORARY__INITIAL__DELAY__MIN

一時ワークスペースのクリーンアップジョブの最初の実行を遅延させる時間。

- デフォルト

-

5

3.3.2.2.1.33. CHE_WORKSPACE_CLEANUP__TEMPORARY__PERIOD__MIN

実行を終了してから次の一時的なワークスペースのクリーンアップジョブの実行を開始するまでの間に遅延する時間

- デフォルト

-

180

3.3.2.2.1.34. CHE_WORKSPACE_SERVER_PING__SUCCESS__THRESHOLD

サーバーへの正常に順次実行される ping の数。この数を超えると、サーバーは利用可能な状態にあるものとして処理されます。OpenShift Dev Sspaces Operator: このプロパティーは、ワークスペース、エージェント、ターミナル、exec などの全サーバーに共通します。

- デフォルト

-

1

3.3.2.2.1.35. CHE_WORKSPACE_SERVER_PING__INTERVAL__MILLISECONDS

ワークスペースサーバーへの連続する ping の間隔 (ミリ秒単位)。

- デフォルト

-

3000

3.3.2.2.1.36. CHE_WORKSPACE_SERVER_LIVENESS__PROBES

liveness プローブを必要とするサーバー名の一覧

- デフォルト

-

wsagent/http,exec-agent/http,terminal,theia,jupyter,dirigible,cloud-shell,intellij

3.3.2.2.1.37. CHE_WORKSPACE_STARTUP__DEBUG__LOG__LIMIT__BYTES

ワークスペースの起動をデバッグする際に che-server で観察される単一コンテナーから収集されるログの制限サイズ。デフォルト値は 10MB=10485760 です。

- デフォルト

-

10485760

3.3.2.2.1.38. CHE_WORKSPACE_STOP_ROLE_ENABLED

true の場合、OpenShift OAuth が有効な場合に、編集権限を持つ「stop-workspace」ロールが「che」 ServiceAccount に付与されます。この設定は、OpenShift OAuth が有効な場合にワークスペースのアイドリングに主に必要になります。

- デフォルト

-

true

3.3.2.2.1.39. CHE_DEVWORKSPACES_ENABLED

DevWorkspaces を有効にして OpenShift Dev Spaces をデプロイするかどうかを指定します。このプロパティーは、DevWorkspaces のサポートもインストールされている場合、OpenShift DevSpacesOperator によって設定されます。このプロパティーは、このファクトを OpenShift Dev Spaces ダッシュボードにアドバタイズするために使用されます。このプロパティーの値を手動で変更することは推奨されません。

- デフォルト

-

false

3.3.2.2.2. 認証パラメーター

3.3.2.2.2.1. CHE_AUTH_USER__SELF__CREATION

OpenShift Dev Spaces には単一の ID 実装があるため、これによってユーザーエクスペリエンスが変わることはありません。true の場合、API レベルでのユーザー作成を有効にします。

- デフォルト

-

false

3.3.2.2.2.2. CHE_AUTH_ACCESS__DENIED__ERROR__PAGE

認証エラーページアドレス

- デフォルト

-

/error-oauth

3.3.2.2.2.3. CHE_AUTH_RESERVED__USER__NAMES

予約済みのユーザー名

- デフォルト

- empty

3.3.2.2.2.4. CHE_OAUTH2_GITHUB_CLIENTID__FILEPATH

GitHub OAuth2 クライアントの設定。パーソナルアクセストークンの取得に使用されます。GitHub クライアント ID を持つファイルの場所。

- デフォルト

-

NULL

3.3.2.2.2.5. CHE_OAUTH2_GITHUB_CLIENTSECRET__FILEPATH

GitHub クライアントシークレットを含むファイルの場所。

- デフォルト

-

NULL

3.3.2.2.2.6. CHE_OAUTH_GITHUB_AUTHURI

GitHub OAuth 認証 URI。

- デフォルト

-

https://github.com/login/oauth/authorize

3.3.2.2.2.7. CHE_OAUTH_GITHUB_TOKENURI

GitHub OAuth トークン URI。

- デフォルト

-

https://github.com/login/oauth/access_token

3.3.2.2.2.8. CHE_OAUTH_GITHUB_REDIRECTURIS

GitHub OAuth リダイレクト URI。複数の値をコンマで区切ります(例: URI,URI,URI)。

- デフォルト

-

http://localhost:${CHE_PORT}/api/oauth/callback

3.3.2.2.2.9. CHE_OAUTH_OPENSHIFT_CLIENTID

OpenShift OAuth クライアントの設定。OpenShift OAuth トークンの取得に使用されます。OpenShift OAuth クライアント ID。

- デフォルト

-

NULL

3.3.2.2.2.10. CHE_OAUTH_OPENSHIFT_CLIENTSECRET

OpenShift OAuth クライアントの設定。OpenShift OAuth トークンの取得に使用されます。OpenShift OAuth クライアント ID。OpenShift OAuth クライアントシークレット。

- デフォルト

-

NULL

3.3.2.2.2.11. CHE_OAUTH_OPENSHIFT_OAUTH__ENDPOINT

Configurationof OpenShift OAuth クライアント。OpenShift OAuth トークンの取得に使用されます。OpenShift OAuth クライアント ID。OpenShift OAuth クライアントシークレット。OpenShift OAuth エンドポイント。

- デフォルト

-

NULL

3.3.2.2.2.12. CHE_OAUTH_OPENSHIFT_VERIFY__TOKEN__URL

ConfigurationofOpenShiftOAuth クライアント。OpenShift OAuth トークンの取得に使用されます。OpenShift OAuth クライアント ID。OpenShift OAuth クライアントシークレット。OpenShift OAuth エンドポイント。OpenShift OAuth 検証トークン URL。

- デフォルト

-

NULL

3.3.2.2.2.13. CHE_OAUTH1_BITBUCKET_CONSUMERKEYPATH

Bitbucket Server OAuth1 クライアントの設定。パーソナルアクセストークンの取得に使用されます。Bitbucket Server アプリケーションのコンシューマーキーが含まれるファイルの場所(ユーザー名と同等)。

- デフォルト

-

NULL

3.3.2.2.2.14. CHE_OAUTH1_BITBUCKET_PRIVATEKEYPATH

Bitbucket Server OAuth1 クライアントの設定パーソナルアクセストークンの取得に使用されます。Bitbucket Server アプリケーションのコンシューマーキーが含まれるファイルの場所(ユーザー名と同等)。Bitbucket Server アプリケーションの秘密鍵が含まれるファイルの場所

- デフォルト

-

NULL

3.3.2.2.2.15. CHE_OAUTH1_BITBUCKET_ENDPOINT

Bitbucket Server OAuth1 クライアントの設定パーソナルアクセストークンの取得に使用されます。Bitbucket Server アプリケーションのコンシューマーキーが含まれるファイルの場所(ユーザー名と同等)。Bitbucket Server アプリケーションの秘密鍵の Bitbucket Server URL が含まれるファイルの場所ファクトリーと正しく連携するには、同じ URL を che.integration.bitbucket.server_endpoints に含める必要があります。

- デフォルト

-

NULL

3.3.2.2.3. 内部

3.3.2.2.3.1. SCHEDULE_CORE__POOL__SIZE

OpenShift Dev Spaces 拡張は、時間に基づいて実行をスケジュールできます。これにより、繰り返されるスケジュールで起動する拡張に割り当てられるスレッドプールのサイズが設定されます。

- デフォルト

-

10

3.3.2.2.3.2. DB_SCHEMA_FLYWAY_BASELINE_ENABLED

DB の初期化および移行設定。trueの場合には、baseline.version で設定Siたバージョンのスクリプトを無視します。

- デフォルト

-

true

3.3.2.2.3.3. DB_SCHEMA_FLYWAY_BASELINE_VERSION

これまでのバージョンを含むスクリプトは無視されます。ベースラインバージョンと同じバージョンのスクリプトも無視されることに注意してください。

- デフォルト

-

5.0.0.8.1

3.3.2.2.3.4. DB_SCHEMA_FLYWAY_SCRIPTS_PREFIX

移行スクリプトの接頭辞

- デフォルト

- empty

3.3.2.2.3.5. DB_SCHEMA_FLYWAY_SCRIPTS_SUFFIX

移行スクリプトの接尾辞。

- デフォルト

-

.sql

3.3.2.2.3.6. DB_SCHEMA_FLYWAY_SCRIPTS_VERSION__SEPARATOR

スクリプト名を他の部分からバージョンを区切るための区切り文字。

- デフォルト

-

__

3.3.2.2.3.7. DB_SCHEMA_FLYWAY_SCRIPTS_LOCATIONS

移行スクリプトを検索する場所。

- デフォルト

-

classpath:che-schema

3.3.2.2.4. Kubernetes インフラパラメーター

3.3.2.2.4.1. CHE_INFRA_KUBERNETES_MASTER__URL

インフラが使用する Kubernetes クライアントマスター URL の設定。

- デフォルト

- empty

3.3.2.2.4.2. CHE_INFRA_KUBERNETES_TRUST__CERTS

Kubernetes クライアントが信頼済みの証明書を使用するように設定するブール値。

- デフォルト

-

false

3.3.2.2.4.3. CHE_INFRA_KUBERNETES_CLUSTER__DOMAIN

Kubernetes クラスタードメイン。設定されていない場合は、svc 名にはクラスタードメインに関する情報が含まれません。

- デフォルト

-

NULL

3.3.2.2.4.4. CHE_INFRA_KUBERNETES_SERVER__STRATEGY

サーバーが Kubernetes インフラでグローバルに公開される方法を定義します。OpenShift Dev Spaces に実装されている戦略のリスト: default-host、multi-host、single-host。

- デフォルト

-

multi-host

3.3.2.2.4.5. CHE_INFRA_KUBERNETES_SINGLEHOST_WORKSPACE_EXPOSURE

ワークスペースのプラグインとエディターを単一ホストモードで公開する方法を定義します。サポートされているエクスポージャー: native :KubernetesIngresses を使用してサーバーをエクスポージャーします。Kubernetes でのみ機能します。gateway: reverse-proxy ゲートウェイを使用してサーバーを公開します。

- デフォルト

-

native

3.3.2.2.4.6. CHE_INFRA_KUBERNETES_SINGLEHOST_WORKSPACE_DEVFILE__ENDPOINT__EXPOSURE

single-host サーバーストラテジーで devfile エンドポイント、エンドユーザーのアプリケーションを公開する方法を定義します。これらは single-host ストラテジーに従い、サブパスで公開されるか、またはサブドメイン上で公開できます。Multi-host: サブドメインで公開されます。single-host: サブパスに公開されます。

- デフォルト

-

multi-host

3.3.2.2.4.7. CHE_INFRA_KUBERNETES_SINGLEHOST_GATEWAY_CONFIGMAP__LABELS

single-host ゲートウェイを設定する ConfigMap に設定されるラベルを定義します。

- デフォルト

-

app=che,component=che-gateway-config

3.3.2.2.4.8. CHE_INFRA_KUBERNETES_INGRESS_DOMAIN

che.infra.kubernetes.server_strategy プロパティーが multi-hostに設定されている場合に、ワークスペースでサーバーのドメインを生成するために使用されます。

- デフォルト

- empty

3.3.2.2.4.9. CHE_INFRA_KUBERNETES_NAMESPACE_CREATION__ALLOWED

OpenShift Dev Spaces サーバーがユーザーワークスペース用のプロジェクトの作成を許可されているか、クラスター管理者が手動で作成することを目的としているかを示します。このプロパティーは OpenShift infra によっても使用されます。

- デフォルト

-

true

3.3.2.2.4.10. CHE_INFRA_KUBERNETES_NAMESPACE_DEFAULT

ユーザーがオーバーライドしない場合にユーザーのワークスペースが作成される Kubernetes のデフォルトの名前空間を定義します。<username> および <userid> プレースホルダー (例: che-workspace-<username>)を使用できます。この場合、ユーザーごとに新規 namespace が作成されます。OpenShift インフラでプロジェクトの指定にも使用されます。<username> または <userid> プレースホルダーは必須です。

- デフォルト

-

<username>-che

3.3.2.2.4.11. CHE_INFRA_KUBERNETES_NAMESPACE_LABEL

che-server がワークスペース namespace にラベルを付けるかどうかを定義します。注: このプロパティーの値を true に設定しておくことを強くお勧めします。false の場合、新しいワークスペース namespace は自動的にラベル付けされないため、OpenShift Dev Spaces Operator によって認識されず、DevWorkspaces の一部の機能が機能しません。false の場合、管理者は che.infra.kubernetes.namespace.labels で指定されたラベルを使用して、namespace に手動でラベルを付ける必要があります。namespace を自分で管理する場合は、必ず https://www.eclipse.org/che/docs/stable/administration-guide/provisioning-namespaces-in-advance/ に従ってください。namespace に存在する追加のラベルはそのまま保持され、機能に影響を与えません。また、このプロパティーが true の場合でも、管理者は手動で namespace を事前に作成してラベルを付けることができます。namespace がすでにラベル付け要件を満たしている場合、namespace の更新は行われません。

- デフォルト

-

true

3.3.2.2.4.12. CHE_INFRA_KUBERNETES_NAMESPACE_ANNOTATE

che-server がワークスペース namespace にアノテーションを付けるかどうかを定義します。

- デフォルト

-

true

3.3.2.2.4.13. CHE_INFRA_KUBERNETES_NAMESPACE_LABELS

OpenShift Dev Spaces Workspaces に使用されるプロジェクトを検索するラベルの一覧。これらは che.infra.kubernetes.namespace.annotations と組み合わせてユーザー用に準備されたプロジェクトを検索し、ワークスペースでプロジェクトをアクティブにラベル付けするのに使用されます。注: OpenShift Dev Spaces Operator は、DevWorkspaces を調整するときにこれらのラベルとその正確な値に依存するため、このプロパティーの値を変更しないことを強くお勧めします。この設定が変更された場合、デフォルトのラベルと値を使用して手動でラベル付けされない限り、namespace は OpenShift Dev Spaces Operator によってワークスペース namespace として自動的に認識されません。namespace に追加のラベルを付けても、機能には影響しません。

- デフォルト

-

app.kubernetes.io/part-of=che.eclipse.org,app.kubernetes.io/component=workspaces-namespace

3.3.2.2.4.14. CHE_INFRA_KUBERNETES_NAMESPACE_ANNOTATIONS

OpenShift Dev Spaces ユーザーワークスペース用に準備されているプロジェクトを検索するアノテーションの一覧。これらのアノテーションと照合されるのは、che.infra.kubernetes.namespace.labels と一致するプロジェクトのみです。このプロジェクトは、che.infra.kubernetes.namespace.labels と che.infra.kubernetes.namespace.annotations 両方に一致するプロジェクトは、優先的にユーザーのワークスペースに使用されます。<username> プレースホルダーを使用して、具体的なユーザーにプロジェクトを指定できます。これらは che.infra.kubernetes.namespace.labels と組み合わせてユーザー用に準備されたプロジェクトを検索し、ワークスペースでプロジェクトにアクティブにアノテーションを付けるのに使用されます。

- デフォルト

-

che.eclipse.org/username=<username>

3.3.2.2.4.15. CHE_INFRA_KUBERNETES_SERVICE__ACCOUNT__NAME

すべてのワークスペース Pod にバインドするように指定する必要がある Kubernetes サービスアカウント名を定義します。Kubernetes インフラストラクチャーがサービスアカウントを作成しない OpenShift Dev Spaces オペレーターであり、存在する必要があります。OpenShift インフラストラクチャーは、プロジェクトが事前に定義されているかどうかをチェックします(che.infra.openshift.project が空でない場合)。これが事前に定義されている場合はサービスアカウントが存在するはずです。これが 'NULL' または空の文字列の場合、インフラストラクチャーはワークスペースごとに新しい OpenShift プロジェクトを作成し、必要なロールを持つワークスペーのスサービスアカウントをここに準備します。

- デフォルト

-

NULL

3.3.2.2.4.16. CHE_INFRA_KUBERNETES_WORKSPACE__SA__CLUSTER__ROLES

ワークスペースサービスアカウントで使用するオプションの追加のクラスターロールを指定します。クラスターロール名がすでに存在している必要がある OpenShift Dev Spaces オペレーター、および OpenShift Dev Spaces サービスアカウントは、これらのクラスターロールをワークスペースサービスアカウントに関連付けるためのロールバインディングを作成できる必要があります。名前はコンマで区切られます。このプロパティーは che.infra.kubernetes.cluster_role_name を非推奨にします。

- デフォルト

-

NULL

3.3.2.2.4.17. CHE_INFRA_KUBERNETES_USER__CLUSTER__ROLES

名前空間でユーザーに割り当てるクラスターの役割

- デフォルト

-

NULL

3.3.2.2.4.18. CHE_INFRA_KUBERNETES_WORKSPACE__START__TIMEOUT__MIN

Kubernetes ワークスペースの開始時間を制限する待機時間を定義します。

- デフォルト

-

8

3.3.2.2.4.19. CHE_INFRA_KUBERNETES_INGRESS__START__TIMEOUT__MIN

Kubernetes Ingress が準備状態になる期間を制限するタイムアウトを分単位で定義します。

- デフォルト

-

5

3.3.2.2.4.20. CHE_INFRA_KUBERNETES_WORKSPACE__UNRECOVERABLE__EVENTS

ワークスペースの起動中に、プロパティーで定義されたリカバリー不可能なイベントが発生する場合は、タイムアウトまで待機するのではなく、ワークスペースをすぐ終了します。OpenShift Dev Spaces Operator: リカバリー不能なイベントが発生する可能性があるため「Failed」の理由だけを追加できません。失敗したコンテナーの起動は、OpenShift Dev Spaces サーバーによって明示的に処理されます。

- デフォルト

-

FailedMount,FailedScheduling,MountVolume.SetUpfailed,Failed to pull image,FailedCreate,ReplicaSetCreateError

3.3.2.2.4.21. CHE_INFRA_KUBERNETES_PVC_ENABLED

OpenShift Dev Spaces ワークスペースの永続ボリュームクレームを使用する必要があるかどうかを定義します。たとえば、プロジェクト、ログをバックアップするか、無効にします。

- デフォルト

-

true

3.3.2.2.4.22. CHE_INFRA_KUBERNETES_PVC_STRATEGY

ワークスペース用に PVC を選択する際に使用するストラテジーを定義します。サポートされる戦略: common: 同じプロジェクト内のすべてのワークスペースは同じ PVC を再利用します。PVC の名前は che.infra.kubernetes.pvc.name で設定できます。既存の PVC が使用されるか、または新規 PVC が存在しない場合にはこれが作成されます。unique: ワークスペースのボリュームごとに個別の PVC が使用されます。PVC の名前は {che.infra.kubernetes.pvc.name} + '-' + {generated_8_chars} として評価されます。既存の PVC が使用されるか、または新規 PVC が存在しない場合にはこれが作成されます。per-workspace: 各ワークスペースに別個の PVC が使用されます。PVC の名前は {che.infra.kubernetes.pvc.name} + '-' + {WORKSPACE_ID} として評価されます。既存の PVC が使用されるか、または新規 PVC が存在しない場合にはこれが作成されます。

- デフォルト

-

common

3.3.2.2.4.23. CHE_INFRA_KUBERNETES_PVC_PRECREATE__SUBPATHS

ワークスペースを起動する前に、common ストラテジーの永続ボリュームでワークスペースのサブパスディレクトリーを作成するジョブを実行するかどうかを定義します。一部のバージョンの OpenShift では、ワークスペースサブパスボリュームマウントが root 権限で作成されるため、ユーザーとして実行されているワークスペースで変更できないため必要です (OpenShift Dev Spaces のワークスペースへのプロジェクトのインポート中にエラーが発生します)。デフォルトは true ですが、OpenShift のバージョンがユーザーパーミッションでサブディレクトリーを作成する場合は false に設定する必要があります。参照: volumeMount の subPath は、root 以外のユーザーには書き込みできません #41638 OpenShift Dev Spaces Operator は、このプロパティーが common PVC 戦略を使用した場合にのみ有効であることを示しています。

- デフォルト

-

true

3.3.2.2.4.24. CHE_INFRA_KUBERNETES_PVC_NAME

OpenShift Dev Spaces ワークスペースの PVC 名の設定を定義します。それぞれの PVC ストラテジーは、この値を異なる方法で指定します。che.infra.kubernetes.pvc.strategy プロパティーに関するドキュメントを参照してください。

- デフォルト

-

claim-che-workspace

3.3.2.2.4.25. CHE_INFRA_KUBERNETES_PVC_STORAGE__CLASS__NAME

ワークスペースの Persistent Volume Claim(永続ボリューム要求、PVC)のストレージクラスを定義します。空の文字列は「use default」を意味します。

- デフォルト

- empty

3.3.2.2.4.26. CHE_INFRA_KUBERNETES_PVC_QUANTITY

OpenShift Dev Spaces ワークスペースの永続ボリュームクレームのサイズを定義します。「永続ストレージについて」を参照してください。

- デフォルト

-

10Gi

3.3.2.2.4.27. CHE_INFRA_KUBERNETES_PVC_JOBS_IMAGE

OpenShift で永続ボリューム要求 (PVC)のメンテナンスジョブを実行する際に起動する Pod

- デフォルト

-

registry.access.redhat.com/ubi8-minimal:8.3-230

3.3.2.2.4.28. CHE_INFRA_KUBERNETES_PVC_JOBS_IMAGE_PULL__POLICY

OpenShift クラスターのメンテナンスジョブに使用されるコンテナーのイメージプルポリシー

- デフォルト

-

IfNotPresent

3.3.2.2.4.29. CHE_INFRA_KUBERNETES_PVC_JOBS_MEMORYLIMIT

永続ボリューム要求のメンテナンスジョブの Pod メモリー制限を定義します。

- デフォルト

-

250 Mi

3.3.2.2.4.30. CHE_INFRA_KUBERNETES_PVC_ACCESS__MODE

Persistent Volume Claim(永続ボリューム要求、PVC)のアクセスモードを定義します。アクセスモードを変更する一般的な PVC ストラテジー向けの OpenShift Dev Spaces Operator は、同時に実行されるワークスペースの数に影響します。OpenShift Dev Spaces を実行している OpenShift インスタンスが RWX アクセスモードでパーシステントボリュームを使用している場合、同時に実行するワークスペースの制限は、OpenShift Dev Spaces の制限設定 (RAM、CPU など) によってのみ制限されます。「永続ストレージについて」を参照してください。

- デフォルト

-

ReadWriteOnce

3.3.2.2.4.31. CHE_INFRA_KUBERNETES_PVC_WAIT__BOUND

OpenShift Dev Spaces Server が、作成後にワークスペースの永続ボリュームクレームがバインドされるのを待機するかどうかを定義します。デフォルト値は true です。このパラメーターは、全 Persistent Volume Claim(永続ボリューム要求、PVC)ストラテジーにより使用されます。volumeBindingMode が WaitForFirstConsumer に設定されている場合は、false に設定する必要があります。それ以外の場合は、ワークスペースの起動が PVC の待機フェーズでハングします。

- デフォルト

-

true

3.3.2.2.4.32. CHE_INFRA_KUBERNETES_INGRESS_ANNOTATIONS__JSON

サーバーを公開するために使用される Ingress のアノテーションを定義します。値は Ingress コントローラーの種類によって異なります。OpenShift インフラストラクチャーは Ingress ではなくルートを使用するため、このプロパティーは無視されます。単一ホストデプロイメントストラテジーが機能する OpenShift Dev Spaces Operator は、URL の書き換えをサポートするコントローラーを使用する必要があります(そのため、サーバーはアプリケーションルートの変更をサポートする必要がありません)。che.infra.kubernetes.ingress.path.rewrite_transform プロパティーは、Ingress のパスが URL の書き換えをサポートするよう変換する方法を定義します。このプロパティーは、選択した Ingress コントローラーに対して実際に URL の書き換えを実行するように指示する ingress 自体のアノテーションのセットを定義します (選択された Ingress コントローラーで必要な場合)。たとえば、Nginx Ingress Controller 0.22.0 以降の場合、次の値が推奨されます: {"ingress.kubernetes.io/rewrite-target": "/$ 1"、"ingress.kubernetes.io/ssl-redirect": "false"、\ "ingress.kubernetes.io/proxy-connect-timeout": "3600"、"ingress.kubernetes.io/proxy-read-timeout": "3600"、"nginx.org/websocket-services": "< service-name>"} および che.infra.kubernetes.ingress.path.rewrite_transform は "%s (。*)" に設定する必要があります。0.22.0 よりも古い nginx Ingress コントローラーの場合には、rewrite-target は / に設定するだけで、パスは %s に変換されます( che.infra.kubernetes.ingress.path.rewrite_transform プロパティーを参照)。Ingress コントローラーが Ingress パスにある正規表現を使用する方法と、URL の書き換えを実行する方法についての説明は、nginx Ingress コントローラーのドキュメントを参照してください。

- デフォルト

-

NULL

3.3.2.2.4.33. CHE_INFRA_KUBERNETES_INGRESS_PATH__TRANSFORM

サーバーを公開する Ingress のパスを宣言する方法についての「recipe」(レシピ) を定義します。%s はサーバーのベース公開 URL を表し、スラッシュで終了することが保証されています。このプロパティーは String.format() メソッドへの有効な入力であり、%s への参照が 1 つだけ含まれる必要があります。Ingress のアノテーションとパスを指定する際にこれら 2 つのプロパティーの相互作用を確認するには、che.infra.kubernetes.ingress.annotations_json プロパティーの説明を参照してください。これが定義されていない場合、このプロパティーはデフォルトで %s (引用符なし) に設定されます。これは、パスが Ingress コントローラーで使用する場合に変換されないことを意味します。

- デフォルト

-

NULL

3.3.2.2.4.34. CHE_INFRA_KUBERNETES_INGRESS_LABELS

明確化できるように、OpenShift Dev Spaces サーバーによって作成されるすべての Ingress に追加する追加のラベル。

- デフォルト

-

NULL

3.3.2.2.4.35. CHE_INFRA_KUBERNETES_POD_SECURITY__CONTEXT_RUN__AS__USER

Kubernetes インフラストラクチャーによって作成される Pod のセキュリティーコンテキストを定義します。これは OpenShift インフラによって無視されます。

- デフォルト

-

NULL

3.3.2.2.4.36. CHE_INFRA_KUBERNETES_POD_SECURITY__CONTEXT_FS__GROUP

Kubernetes インフラストラクチャーによって作成される Pod のセキュリティーコンテキストを定義します。Pod の全コンテナーに適用される特別な補助グループです。OpenShift インフラは、このグループを無視します。

- デフォルト

-

NULL

3.3.2.2.4.37. CHE_INFRA_KUBERNETES_POD_TERMINATION__GRACE__PERIOD__SEC

OpenShift インフラストラクチャーによって作成される Pod の猶予期間を定義します。デフォルト値: 0これにより、Pod をすぐに停止し、ワークスペースの停止に必要な時間を短縮できます。OpenShift Dev Spaces Operator: terminationGracePeriodSeconds が OpenShift レシピで明示的に設定されている場合は上書きされません。

- デフォルト

-

0

3.3.2.2.4.38. CHE_INFRA_KUBERNETES_TLS__ENABLED

Transport Layer Security(TLS)を有効にして Ingress を作成します。OpenShift インフラストラクチャーではルートは TLS に対応します。

- デフォルト

-

false

3.3.2.2.4.39. CHE_INFRA_KUBERNETES_TLS__SECRET

TLS でワークスペース Ingress を作成する際に使用すべきシークレットの名前。OpenShift インフラストラクチャーでは、このプロパティーは無視されます。

- デフォルト

- empty

3.3.2.2.4.40. CHE_INFRA_KUBERNETES_TLS__KEY

ワークスペース Ingress に使用する必要のある TLS Secret のデータ。cert および key は Base64 アルゴリズムでエンコードする必要があります。OpenShift インフラストラクチャーでは、これらのプロパティーは無視されます。

- デフォルト

-

NULL

3.3.2.2.4.41. CHE_INFRA_KUBERNETES_TLS__CERT

ワークスペース Ingress に使用する必要のある TLS Secret の証明書データ。証明書は、Base64 アルゴリズムでエンコードする必要があります。OpenShift インフラストラクチャーでは、このプロパティーは無視されます。

- デフォルト

-

NULL

3.3.2.2.4.42. CHE_INFRA_KUBERNETES_RUNTIMES__CONSISTENCY__CHECK__PERIOD__MIN

ランタイムの整合性チェックが実行される期間を定義します。ランタイムに一貫性のない状態がある場合、ランタイムは自動的に停止します。値は 0 をより大きな値、または -1 である必要があります。ここで、-1 はチェックが実行されないことを意味します。OpenShift Dev Spaces Server がユーザーが操作を呼び出していない場合に Kubernetes API と対話できない場合に、OpenShift Dev Spaces サーバー設定が可能な OpenShift Dev Spaces サーバー設定があるため、デフォルトでは無効になっています。以下の設定で機能します。- ワークスペースオブジェクトは、OpenShift Dev Spaces Server が配置されているのと同じ名前空間に作成されます。- cluster-admin サービスアカウントトークンが OpenShift Dev Spaces サーバー Pod にマウントされます。OpenShift Dev Spaces Server は、OAuth プロバイダーからのトークンを使用して Kubernetes API と通信します。

- デフォルト

-

-1

3.3.2.2.4.43. CHE_INFRA_KUBERNETES_TRUSTED__CA_SRC__CONFIGMAP

すべてのユーザーのワークスペースに伝播される追加の CATLS 証明書を含む OpenShift Dev Spaces サーバー名前空間の ConfigMap の名前。プロパティーを OpenShift 4 インフラストラクチャーに設定し、che.infra.openshift.trusted_ca.dest_configmap_labels に config.openshift.io/inject-trusted-cabundle=true ラベルが含まれる場合に、クラスター CA バンドルも伝播されます。

- デフォルト

-

NULL

3.3.2.2.4.44. CHE_INFRA_KUBERNETES_TRUSTED__CA_DEST__CONFIGMAP

追加の CA TLS 証明書を含むワークスペース namespace の設定マップの名前。ワークスペース namespace にある che.infra.kubernetes.trusted_ca.src_configmap のコピーを保持します。この設定マップの内容は、プラグインブローカーを含むすべてのワークスペースコンテナーにマウントされます。既存の ConfigMap と競合しない限り、ConfigMap 名を変更しないでください。結果の ConfigMap 名を最終的に調整してプロジェクト内で一意にすることができる OpenShift Dev SpacesOperator。元の名前は che.original_name ラベルに保存されます。

- デフォルト

-

ca-certs

3.3.2.2.4.45. CHE_INFRA_KUBERNETES_TRUSTED__CA_MOUNT__PATH

CA バンドルがマウントされるワークスペースコンテナーでパスを設定します。che.infra.kubernetes.trusted_ca.dest_configmap で指定される設定マップの内容がマウントされます。

- デフォルト

-

/public-certs

3.3.2.2.4.46. CHE_INFRA_KUBERNETES_TRUSTED__CA_DEST__CONFIGMAP__LABELS

ユーザーワークスペースの CA 証明書の設定マップに追加するラベルのコンマ区切りの一覧。che.infra.kubernetes.trusted_ca.dest_configmap プロパティーを参照してください。

- デフォルト

- empty

3.3.2.2.5. OpenShift インフラパラメーター

3.3.2.2.5.1. CHE_INFRA_OPENSHIFT_TRUSTED__CA_DEST__CONFIGMAP__LABELS

ユーザーワークスペースの CA 証明書の設定マップに追加するラベルのコンマ区切りの一覧。che.infra.kubernetes.trusted_ca.dest_configmap プロパティーを参照してください。このデフォルト値は、OpenShift 4 でのクラスター CA バンドルの自動挿入に使用されます。

- デフォルト

-

config.openshift.io/inject-trusted-cabundle=true

3.3.2.2.5.2. CHE_INFRA_OPENSHIFT_ROUTE_LABELS

OpenShift Dev Spaces サーバーによって作成されたすべてのルートに追加する追加のラベルにより、明確な識別が可能になります。

- デフォルト

-

NULL

3.3.2.2.5.3. CHE_INFRA_OPENSHIFT_ROUTE_HOST_DOMAIN__SUFFIX

ワークスペースルートの接尾辞として使用する必要のあるホスト名。例: domain_suffix=<devspaces-__<openshift_deployment_name>__.__<domain_name>__> を仕様すると、ルートは routed3qrtk.<devspaces-__<openshift_deployment_name>__.__<domain_name>__> のようになります。有効な DNS 名である必要があります。

- デフォルト

-

NULL

3.3.2.2.5.4. CHE_INFRA_OPENSHIFT_PROJECT_INIT__WITH__SERVER__SA

OpenShift OAuth が有効な場合に、OpenShift Dev Spaces サーバーのサービスアカウントで OpenShift プロジェクトを初期化します。

- デフォルト

-

true

3.3.2.2.6. 実験的なプロパティー

3.3.2.2.6.1. CHE_WORKSPACE_PLUGIN__BROKER_METADATA_IMAGE

ワークスペースツール設定を解決し、プラグインの依存関係をワークスペースにコピーする OpenShift Dev Spaces プラグインブローカーアプリケーションの Docker イメージ。OpenShift Dev Spaces Operator はデフォルトでこれらのイメージを上書きします。OpenShift Dev Spaces が Operator を使用してインストールされている場合、ここでイメージを変更しても効果がありません。

- デフォルト

-

quay.io/eclipse/che-plugin-metadata-broker:v3.4.0

3.3.2.2.6.2. CHE_WORKSPACE_PLUGIN__BROKER_ARTIFACTS_IMAGE

OpenShift Dev Spaces プラグインのアーティファクトブローカーの Docker イメージ。このブローカーは、ワークスペース Pod で init コンテナーとして実行されます。このジョブは、プラグインの ID (レジストリー内のプラグインへの参照または、プラグインの meta.yaml へのリンク) の一覧を取り、ワークスペース向けに要求されたプラグインごとに、正しい .vsix and .theia 拡張子が /plugins ディレクトリーにダウンロードされていることを確認します。

- デフォルト

-

quay.io/eclipse/che-plugin-artifacts-broker:v3.4.0

3.3.2.2.6.3. CHE_WORKSPACE_PLUGIN__BROKER_DEFAULT__MERGE__PLUGINS

プラグインをワークスペースにプロビジョニングする際にプラグインブローカーのデフォルト動作を設定します。true に設定すると、プラグインブローカーは可能な場合にプラグインのマージを試行します(つまり、それらは同じサイドカーイメージで実行され、設定が競合することはありません)。この値は、devfile で mergePlugins 属性が指定されていない場合に使用されるデフォルト設定です。

- デフォルト

-

false

3.3.2.2.6.4. CHE_WORKSPACE_PLUGIN__BROKER_PULL__POLICY

ワークスペースツール設定を解決し、プラグインの依存関係をワークスペースにコピーする OpenShift Dev Spaces プラグインブローカーアプリケーションの Docker イメージ

- デフォルト

-

Always

3.3.2.2.6.5. CHE_WORKSPACE_PLUGIN__BROKER_WAIT__TIMEOUT__MIN

プラグインブローカーの待機中に結果の最大期間を制限するタイムアウトを分単位で定義します。

- デフォルト

-

3

3.3.2.2.6.6. CHE_WORKSPACE_PLUGIN__REGISTRY__URL

ワークスペースプラグインレジストリーのエンドポイント。有効な HTTP URL でなければなりません。例: http://che-plugin-registry-eclipse-che.192.168.65.2.nip.io OpenShift Dev Spaces プラグインレジストリーが不要な場合、値 'NULL' を使用する必要があります。

- デフォルト

-

https://che-plugin-registry.prod-preview.openshift.io/v3

3.3.2.2.6.7. CHE_WORKSPACE_PLUGIN__REGISTRY__INTERNAL__URL

ワークスペースプラグインレジストリーの内部エンドポイント。有効な HTTP URL でなければなりません。例: http://devfile-registry.che.svc.cluster.local:8080 OpenShift Dev Spaces プラグインレジストリーが不要な場合、値 'NULL' を使用する必要があります

- デフォルト

-

NULL

3.3.2.2.6.8. CHE_WORKSPACE_DEVFILE__REGISTRY__URL

devfile レジストリーエンドポイント。有効な HTTP URL でなければなりません。例: http://che-devfile-registry-eclipse-che.192.168.65.2.nip.io OpenShift Dev Spaces プラグインレジストリーが不要な場合、値 'NULL' を使用する必要があります。

- デフォルト

-

https://che-devfile-registry.prod-preview.openshift.io/

3.3.2.2.6.9. CHE_WORKSPACE_DEVFILE__REGISTRY__INTERNAL__URL

devfile レジストリー "internal" エンドポイント。有効な HTTP URL でなければなりません。例: http://plugin-registry.che.svc.cluster.local:8080 OpenShift Dev Spaces プラグインレジストリーが不要な場合、値 'NULL' を使用する必要があります

- デフォルト

-

NULL

3.3.2.2.6.10. CHE_WORKSPACE_STORAGE_AVAILABLE__TYPES

ダッシュボードなどのクライアントがワークスペースの作成/更新時にユーザーに提案するストレージタイプに使用できる値を定義する設定プロパティー。使用できる値: - persistent: 永続ストレージの I/O は低速だが永続性がある。- ephemeral: 一時ストレージは、高速 I/O を可能にするが、ストレージには制限があり、永続性がない。- async: 実験的機能: 非同期ストレージは一時ストレージと永続ストレージの組み合わせ。高速な I/O を可能にし、変更を維持し、停止時にバックアップを実行し、ワークスペースの開始時に復元します。che.infra.kubernetes.pvc.strategy='common' - che.limits.user.workspaces.run.count=1 - che.infra.kubernetes.namespace.default に <username> が含まれる場合にのみ機能します。それ他の場合は、一覧から async を削除します。

- デフォルト

-

persistent,ephemeral,async

3.3.2.2.6.11. CHE_WORKSPACE_STORAGE_PREFERRED__TYPE

ダッシュボードなどのクライアントがワークスペースの作成/更新時にユーザーに提案するストレージタイプのデフォルト値を定義する設定プロパティー。async 値は実験的な機能であるため、デフォルトタイプとしての使用は推奨されません。

- デフォルト

-

永続

3.3.2.2.6.12. CHE_SERVER_SECURE__EXPOSER

セキュアなサーバーが認証で保護される方法を設定します。適切な値: default: jwtproxy はパススルーモードで設定されます。そのため、サーバーは要求を認証する必要があります。jwtproxy: jwtproxy は要求を認証します。そのため、サーバーは認証済みの要求のみを受信します。

- デフォルト

-

jwtproxy

3.3.2.2.6.13. CHE_SERVER_SECURE__EXPOSER_JWTPROXY_TOKEN_ISSUER

署名のない要求をルーティングするための Jwtproxy 発行側の文字列、トークンの有効期間およびオプションの認証ページのパス。

- デフォルト

-

wsmaster

3.3.2.2.6.14. CHE_SERVER_SECURE__EXPOSER_JWTPROXY_TOKEN_TTL

jwtproxy 発行者トークンの有効期間。

- デフォルト

-

8800h

3.3.2.2.6.15. CHE_SERVER_SECURE__EXPOSER_JWTPROXY_AUTH_LOADER_PATH

署名なしの要求をルーティングする認証ページのパス (任意)。

- デフォルト

-

/_app/loader.html

3.3.2.2.6.16. CHE_SERVER_SECURE__EXPOSER_JWTPROXY_IMAGE

jwtproxy イメージ。

- デフォルト

-

quay.io/eclipse/che-jwtproxy:0.10.0

3.3.2.2.6.17. CHE_SERVER_SECURE__EXPOSER_JWTPROXY_MEMORY__REQUEST

jwtproxy メモリー要求。

- デフォルト

-

15mb

3.3.2.2.6.18. CHE_SERVER_SECURE__EXPOSER_JWTPROXY_MEMORY__LIMIT

jwtproxy メモリー制限。

- デフォルト

-

128mb

3.3.2.2.6.19. CHE_SERVER_SECURE__EXPOSER_JWTPROXY_CPU__REQUEST

jwtproxy CPU 要求。

- デフォルト

-

0.03

3.3.2.2.6.20. CHE_SERVER_SECURE__EXPOSER_JWTPROXY_CPU__LIMIT

jwtproxy CPU 制限。

- デフォルト

-

0.5

3.3.2.2.7. 主なWebSocketエンドポイントの設定

3.3.2.2.7.1. CHE_CORE_JSONRPC_PROCESSOR__MAX__POOL__SIZE

JSON RPC 処理プールの最大サイズ。プールサイズが超過すると、メッセージの実行が拒否されます。

- デフォルト

-

50

3.3.2.2.7.2. CHE_CORE_JSONRPC_PROCESSOR__CORE__POOL__SIZE

初期 JSON 処理プール。主な JSON RPC メッセージを処理するために使用されるスレッドの最小数。

- デフォルト

-

5

3.3.2.2.7.3. CHE_CORE_JSONRPC_PROCESSOR__QUEUE__CAPACITY

Json RPC メッセージの処理に使用するキューの設定。

- デフォルト

-

100000

3.3.2.2.7.4. CHE_METRICS_PORT

Prometheus メトリクスで公開される HTTP サーバーエンドポイントのポート

- デフォルト

-

8087

3.3.2.2.8. CORS 設定

3.3.2.2.8.1. CHE_CORS_ALLOWED__ORIGINS

許可される要求元を指定します。WS Master の CORS フィルターはデフォルトで無効にされます。環境変数 "CHE_CORS_ENABLED=true" を使用してオンにします。

- デフォルト

-

*

3.3.2.2.8.2. CHE_CORS_ALLOW__CREDENTIALS

認証情報 (cookie、ヘッダー、TLS クライアント証明書) を使用して要求の処理を許可するかどうかを示します。

- デフォルト

-

false

3.3.2.2.9. Factory のデフォルト

3.3.2.2.9.1. CHE_FACTORY_DEFAULT__PLUGINS

OpenShift Dev Spaces 固有のワークスペース記述子が含まれないリモート git リポジトリーから作成される Factory 用に作成されるエディターおよびプラグイン。複数のプラグインは、以下のようにコンマで区切る必要があります。例: pluginFooPublisher/pluginFooName/pluginFooVersion,pluginBarPublisher/pluginBarName/pluginBarVersion

- デフォルト

-

redhat/vscode-commons/latest

3.3.2.2.9.2. CHE_FACTORY_DEFAULT__DEVFILE__FILENAMES

リポジトリーベースの Factory(GitHub など)を検索する devfile のファイル名。Factory は、プロパティーで列挙される順序でこれらのファイルの特定を試みます。

- デフォルト

-

devfile.yaml,.devfile.yaml

3.3.2.2.10. devfile のデフォルト

3.3.2.2.10.1. CHE_FACTORY_DEFAULT__EDITOR

OpenShift Dev Spaces 固有のワークスペース記述子が含まれないリモート Git リポジトリーから作成される Factory に使用されるエディター。

- デフォルト

-

eclipse/che-theia/latest

3.3.2.2.10.2. CHE_FACTORY_SCM__FILE__FETCHER__LIMIT__BYTES

SCM リポジトリーからファイルを取得する URL フェッチャーのファイルサイズ制限。

- デフォルト

-

102400

3.3.2.2.10.3. CHE_FACTORY_DEVFILE2__FILES__RESOLUTION__LIST

devfile v2 を補完する追加ファイルで、リポジトリーに含まれる場合があり、取得するには Factory の SCM リゾルバーサービスへのリンクとして参照する必要があります。

- デフォルト

-

.che/che-editor.yaml,.che/che-theia-plugins.yaml,.vscode/extensions.json

3.3.2.2.10.4. CHE_WORKSPACE_DEVFILE_DEFAULT__EDITOR

指定されていない場合に Devfile にプロビジョニングする必要があるデフォルトのエディター。エディター形式は、editorPublisher/editorName/editorVersion 値になります。NULL または値がない場合は、デフォルトのエディターはプロビジョニングされません。

- デフォルト

-

eclipse/che-theia/latest

3.3.2.2.10.5. CHE_WORKSPACE_DEVFILE_DEFAULT__EDITOR_PLUGINS

デフォルトのエディター用にプロビジョニングする必要があるデフォルトのプラグイン。ユーザー定義の devfile で明示的に参照されていないこの一覧のすべてのプラグインはプロビジョニングされますが、これはデフォルトのエディターが使用されているか、またはユーザー定義のエディターが (異なるバージョンの場合でも) デフォルトと同じである場合に限ります。形式は、コンマ区切りの pluginPublisher/pluginName/pluginVersion 値および URL です。例: eclipse/che-theia-exec-plugin/0.0.1,eclipse/che-theia-terminal-plugin/0.0.1,https://cdn.pluginregistry.com/vi-mode/meta.yaml プラグインが URL の場合、プラグインの meta.yaml はその URL から取得されます。

- デフォルト

-

NULL

3.3.2.2.10.6. CHE_WORKSPACE_PROVISION_SECRET_LABELS

ユーザー namespace からシークレットを選択するためにラベルのコンマ区切りの一覧を定義します。これは、ファイルまたは環境変数としてワークスペースコンテナーにマウントされます。すべての指定されるラベルに一致するシークレットのみが選択されます。

- デフォルト

-

app.kubernetes.io/part-of=che.eclipse.org,app.kubernetes.io/component=workspace-secret

3.3.2.2.10.7. CHE_WORKSPACE_DEVFILE_ASYNC_STORAGE_PLUGIN

非同期ストレージ機能がワークスペース設定で有効にされ、環境でサポートされる場合に、プラグインが追加されます。

- デフォルト

-

eclipse/che-async-pv-plugin/latest

3.3.2.2.10.8. CHE_INFRA_KUBERNETES_ASYNC_STORAGE_IMAGE

OpenShift Dev Spaces 非同期ストレージの Docker イメージ

- デフォルト

-

quay.io/eclipse/che-workspace-data-sync-storage:0.0.1

3.3.2.2.10.9. CHE_WORKSPACE_POD_NODE__SELECTOR

オプションでワークスペース Pod のノードセレクターを設定します。形式は、コンマ区切りの key=value ペアです (例: disktype=ssd,cpu=xlarge,foo=bar)。

- デフォルト

-

NULL

3.3.2.2.10.10. CHE_WORKSPACE_POD_TOLERATIONS__JSON

オプションでワークスペース Pod の容認を設定します。形式は、テイントの容認の JSON 配列を表す文字列か、または NULL の場合はこれを無効にします。配列に含まれるオブジェクトは、toleration v1 コア仕様 に準拠する必要があります。例: [{"effect":"NoExecute","key":"aNodeTaint","operator":"Equal","value":"aValue"}]

- デフォルト

-

NULL

3.3.2.2.10.11. CHE_INFRA_KUBERNETES_ASYNC_STORAGE_SHUTDOWN__TIMEOUT__MIN

最後に使用されたワークスペースの停止後の非同期ストレージ Pod のシャットダウンのタイムアウト。0 以下の値は、シャットダウン機能を無効にするものとして解釈されます。

- デフォルト

-

120

3.3.2.2.10.12. CHE_INFRA_KUBERNETES_ASYNC_STORAGE_SHUTDOWN__CHECK__PERIOD__MIN

非同期ストレージ Pod が機能を停止する期間を定義します (デフォルトでは 30 分ごと)。

- デフォルト

-

30

3.3.2.2.10.13. CHE_INTEGRATION_BITBUCKET_SERVER__ENDPOINTS

Factory の統合に使用される Bitbucket エンドポイント。bitbucket サーバー URL のコンマ区切りの一覧、または統合が予想されない場合は NULL。

- デフォルト

-

NULL

3.3.2.2.10.14. CHE_INTEGRATION_GITLAB_SERVER__ENDPOINTS

Factory の統合に使用される GitLab エンドポイント。GitLab サーバー URL のコンマ区切りの一覧、または統合が予想されない場合は NULL。

- デフォルト

-

NULL

3.3.2.2.10.15. CHE_INTEGRATION_GITLAB_OAUTH__ENDPOINT

OAuth 2 統合が設定された GitLab サーバーのアドレス

- デフォルト

-

NULL

3.3.2.2.10.16. CHE_OAUTH2_GITLAB_CLIENTID__FILEPATH

GitLab OAuth2 クライアントの設定。パーソナルアクセストークンの取得に使用されます。GitLab クライアント ID を持つファイルの場所。

- デフォルト

-

NULL

3.3.2.2.10.17. CHE_OAUTH2_GITLAB_CLIENTSECRET__FILEPATH

GitLab クライアントシークレットを含むファイルの場所。

- デフォルト

-

NULL#

3.3.2.2.11. Che システム

3.3.2.2.11.1. CHE_SYSTEM_SUPER__PRIVILEGED__MODE

System Super Privileged Mode (システムのスーパー特権モード)。getByKey、getByNameSpace、stopWorkspaces、および getResources の manageSystem パーミッションの追加パーミッションをユーザーに付与します。これらは、デフォルトでは管理者には提供されず、これらのパーミッションにより、管理者はadmin 権限でそれらのワークスペースに名前を指定し、ワークスペースへの可視性を得ることができます。

- デフォルト

-

false

3.3.2.2.11.2. CHE_SYSTEM_ADMIN__NAME

che.admin.nameユーザーのシステムパーミッションを付与します。ユーザーがすでに存在する場合は、これはコンポーネントの起動時に生じます。ユーザーがすでに存在しない場合は、ユーザーがデータベースで永続化される初回のログイン時に発生します。

- デフォルト

-

admin

3.3.2.2.12. Workspace の制限

3.3.2.2.12.1. CHE_LIMITS_WORKSPACE_ENV_RAM

ワークスペースは、開発を行う際のユーザー向けの基本的なランタイムです。ワークスペースの作成方法や、消費されるリソースを制限するパラメーターを設定できます。ユーザーが新規ワークスペースの作成時にワークスペースに割り当てることができる RAM の最大量。RAM スライダーは、この最大値に合わせて調整されます。

- デフォルト

-

16gb

3.3.2.2.12.2. CHE_LIMITS_WORKSPACE_IDLE_TIMEOUT

システムがワークスペースを一時停止した後にこれを停止する際に、ユーザーがワークスペースでアイドル状態になる期間 (ミリ秒単位)。アイドル状態は、ユーザーがワークスペースと対話しない期間です。つまり、エージェントのいずれも対話を受け取っていない期間を意味します。ブラウザーウィンドウを開いたままにするとアイドル状態になります。

- デフォルト

-

1800000

3.3.2.2.12.3. CHE_LIMITS_WORKSPACE_RUN_TIMEOUT

システムが一時停止するまでの、アクティビティーを問わず、ワークスペースが実行される期間 (ミリ秒単位)。一定期間後にワークスペースを自動的に停止する場合は、このプロパティーを設定します。デフォルトはゼロで、実行タイムアウトがないことを意味します。

- デフォルト

-

0

3.3.2.2.13. ユーザーワークスペースの制限

3.3.2.2.13.1. CHE_LIMITS_USER_WORKSPACES_RAM

単一ユーザーがワークスペースの実行に割り当てることができる RAM の合計量。ユーザーは、この RAM を単一のワークスペースに割り当てるか、または複数のワークスペースに分散することができます。

- デフォルト

-

-1

3.3.2.2.13.2. CHE_LIMITS_USER_WORKSPACES_COUNT

ユーザーが作成できるワークスペースの最大数。追加のワークスペースを作成しようとすると、ユーザーにはエラーメッセージが表示されます。これは、実行中および停止中のワークスペースの合計数に適用されます。

- デフォルト

-

-1

3.3.2.2.13.3. CHE_LIMITS_USER_WORKSPACES_RUN_COUNT

単一ユーザーが持てる実行中のワークスペースの最大数。ユーザーがこのしきい値に達し、追加のワークスペースを開始しようとすると、エラーメッセージと共にプロンプトが表示されます。ユーザーは、実行中のワークスペースを停止してから別のワークスペースをアクティべートする必要があります。

- デフォルト

-

1

3.3.2.2.14. 組織ワークスペースの制限

3.3.2.2.14.1. CHE_LIMITS_ORGANIZATION_WORKSPACES_RAM

単一組織 (チーム) がワークスペースの実行に割り当てることができる RAM の合計量。組織の所有者はこの RAM を割り当てることができますが、チームのワークスペース全体で適切に割り当てられているように見えます。

- デフォルト

-

-1

3.3.2.2.14.2. CHE_LIMITS_ORGANIZATION_WORKSPACES_COUNT

組織が所有できるワークスペースの最大数。追加のワークスペースを作成しようとすると、組織にはエラーメッセージが表示されます。これは、実行中および停止中のワークスペースの合計数に適用されます。

- デフォルト

-

-1

3.3.2.2.14.3. CHE_LIMITS_ORGANIZATION_WORKSPACES_RUN_COUNT

単一組織が持てる実行中のワークスペースの最大数。組織がこのしきい値に達し、追加のワークスペースを開始しようとすると、エラーメッセージと共にプロンプトが表示されます。組織は、実行中のワークスペースを停止してから別のワークスペースをアクティべートする必要があります。

- デフォルト

-

-1

3.3.2.2.15. マルチユーザー固有の OpenShift インフラストラクチャー設定

3.3.2.2.15.1. CHE_INFRA_OPENSHIFT_OAUTH__IDENTITY__PROVIDER

Keycloak に登録されている OpenShiftID プロバイダーのエイリアス。現在の OpenShift Dev Spaces ユーザーが所有する OpenShift 名前空間にワークスペース OpenShift リソースを作成するために使用する必要があります。che.infra.openshift.project が空白以外の値に設定する場合は NULL に設定する必要があります。OpenShift アイデンティティープロバイダーを参照してください。

- デフォルト

-

NULL

3.3.2.2.16. OIDC 設定

3.3.2.2.16.1. CHE_OIDC_AUTH__SERVER__URL

OIDC ID プロバイダーサーバーへの URL は、che.oidc.oidcProvider が使用されている場合にのみ NULL に設定できます。

- デフォルト

-

http://${CHE_HOST}:5050/auth

3.3.2.2.16.2. CHE_OIDC_AUTH__INTERNAL__SERVER__URL

内部ネットワークサービス URL から OIDC ID プロバイダーサーバー

- デフォルト

-

NULL

3.3.2.2.16.3. CHE_OIDC_ALLOWED__CLOCK__SKEW__SEC

exp または nbf 要求を検証する際にクロックスキューについて許容される秒数。

- デフォルト

-

3

3.3.2.2.16.4. CHE_OIDC_USERNAME__CLAIM

ユーザー名は、JWT トークンを解析するときにユーザー表示名として使用されると主張します。定義されていない場合、フォールバック値は Keycloak インストールでは 'preferred_username' であり、Dex インストールでは name です。

- デフォルト

-

NULL

3.3.2.2.16.5. CHE_OIDC_OIDC__PROVIDER

この仕様 (Obtaining OpenID Provider Configuration Information) で詳細に検出エンドポイントを指定する別の OIDC プロバイダーのベース URL。非推奨。代わりに che.oidc.auth_server_url および che.oidc.auth_internal_server_url を使用します。

- デフォルト

-

NULL

3.3.2.2.17. Keycloak の設定

3.3.2.2.17.1. CHE_KEYCLOAK_REALM

Keycloak レルムを使用してユーザーを認証するために使用されます。che.keycloak.oidcProvider が使用している場合のみ NULL に設定できます。

- デフォルト

-

che

3.3.2.2.17.2. CHE_KEYCLOAK_CLIENT__ID

ダッシュボード、IDE、および CLI でユーザーを認証する che.keycloak.realm の Keycloak クライアント識別子。

- デフォルト

-

che-public

3.3.2.2.17.3. CHE_KEYCLOAK_OSO_ENDPOINT

OSO OAuth トークンにアクセスするための URL

- デフォルト

-

NULL

3.3.2.2.17.4. CHE_KEYCLOAK_GITHUB_ENDPOINT