管理ガイド

Administering Red Hat OpenShift Dev Spaces 3.12

概要

第1章 インストールの準備

OpenShift Dev Spaces インストールを準備するには、OpenShift Dev Spaces エコシステムおよびデプロイメントの制約について確認します。

1.1. サポート対象のプラットフォーム

OpenShift Dev Spaces は、次の CPU アーキテクチャー上の OpenShift 4.12 - 4.15 で実行されます。

-

AMD64 および Intel 64 (

x86_64) -

IBM Power (

ppc64le) および IBM Z (s390x)

関連情報

1.2. dsc 管理ツールのインストール

Red Hat OpenShift Dev Spaces コマンドライン管理ツールである dsc は、Microsoft Windows、Apple MacOS、および Linux にインストールできます。dsc を使用すると、サーバーの起動、停止、更新、削除など、OpenShift Dev Spaces サーバーの操作を実行できます。

前提条件

Linux または macOS の場合:

注記Windows に

dscをインストールする場合は、以下のページを参照してください。

手順

-

https://developers.redhat.com/products/openshift-dev-spaces/download から

$HOMEなどのディレクトリーにアーカイブをダウンロードします。 -

アーカイブで

tar xvzfを実行して、/dscディレクトリーをデプロイメントします。 -

デプロイメントした

/dsc/binサブディレクトリーを$PATHに追加します。

検証

dscを実行して、その情報を表示します。$ dsc

関連情報

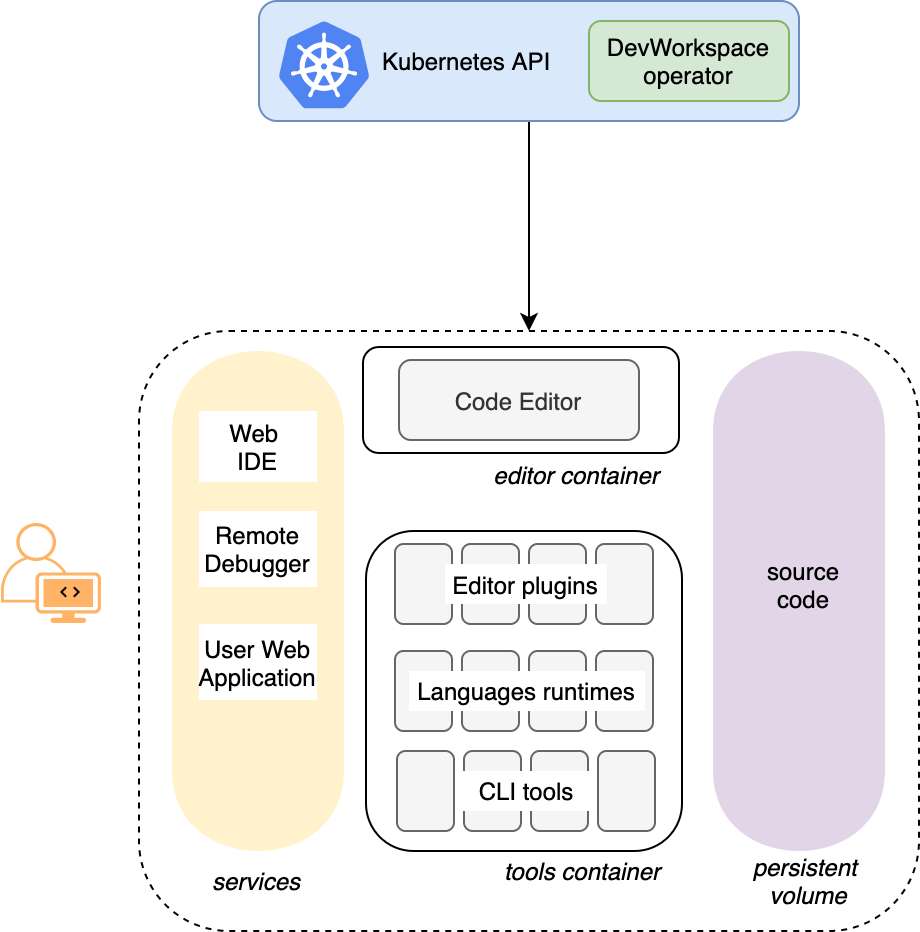

1.3. アーキテクチャー

図1.1 Dev Workspace Operator を使用した高度な OpenShift Dev Spaces アーキテクチャー

OpenShift Dev Spaces は、3 つのコンポーネントのグループで実行されます。

- OpenShift Dev Spaces サーバーコンポーネント

- ユーザープロジェクトおよびワークスペースの管理。主な設定要素はユーザーダッシュボードで、ユーザーはここから自分のワークスペースを制御します。

- Dev ワークスペースの演算子

-

User ワークスペースの実行に必要な OpenShift オブジェクトを作成し、制御します。

Pod、Services、およびPersistentVolumesが含まれます。 - User ワークスペース

- コンテナーベースの開発環境、IDE を含みます。

これらの OpenShift の機能のロールは中心的なものです。

- Dev ワークスペースのカスタムリソース

- ユーザーワークスペースを表す有効な OpenShift オブジェクト。OpenShift Dev Spaces で操作します。3 つのグループのコンポーネントのコミュニケーションチャンネルとなります。

- OpenShift のロールベースアクセスコントロール (RBAC)

- すべてのリソースへのアクセスを制御します。

1.3.1. サーバーコンポーネント

OpenShift Dev Spaces サーバーコンポーネントにより、マルチテナンシーとワークスペースの管理が確保されます。

図1.2 Dev Workspace Operator と対話する OpenShift Dev Spaces サーバーコンポーネント

関連情報

1.3.1.1. Dev Spaces オペレーター

OpenShift Dev Spaces Operator は、OpenShift Dev Spaces サーバーコンポーネントの完全なライフサイクル管理を行います。これには、以下が含まれます。

CheClusterカスタムリソース定義 (CRD)-

CheClusterOpenShift オブジェクトを定義します。 - OpenShift Dev Spaces コントローラー

- Pod、サービス、永続ボリュームなどの OpenShift Dev Space インスタンスを実行するために必要な OpenShift オブジェクトを作成し、制御します。

CheClusterカスタムリソース (CR)OpenShift Dev Spaces Operator を持つクラスターでは、

CheClusterカスタムリソース (CR) を作成できます。OpenShift Dev Spaces オペレーターは、この OpenShift Dev Spaces インスタンス上で OpenShift Dev Spaces サーバーコンポーネントの完全なライフサイクル管理を行います。

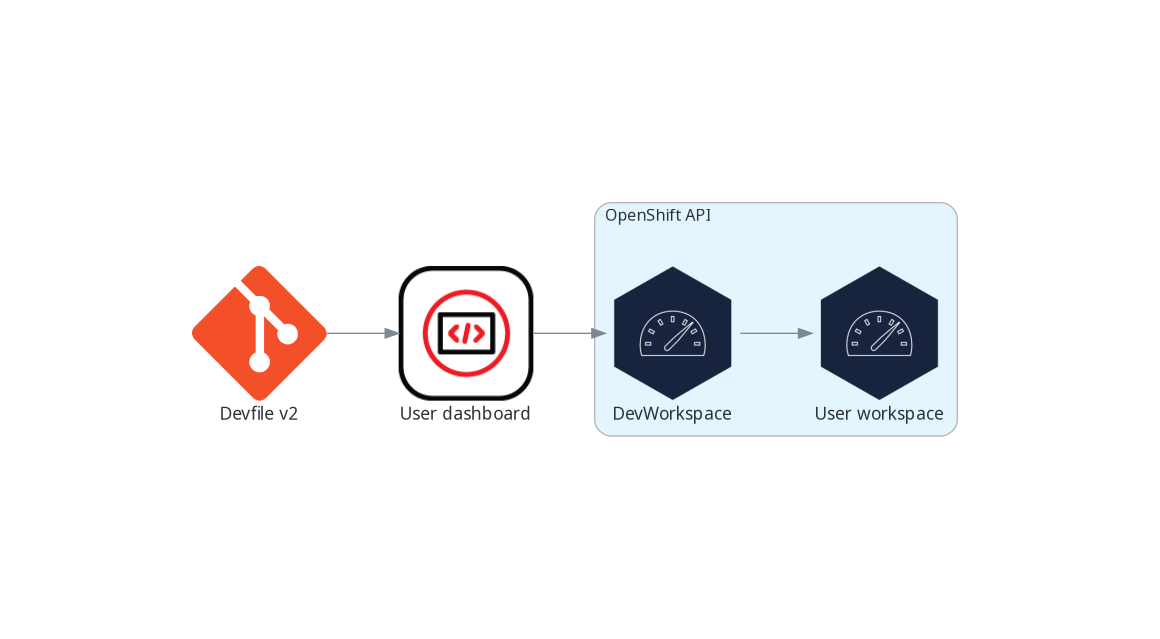

1.3.1.2. Dev ワークスペースの演算子

Dev Workspace 演算子は、OpenShift を拡張して Dev Workspace のサポートを提供します。これには、以下が含まれます。

- Dev Workspace のカスタムリソース定義

- Devfile v2 仕様から Dev Workspace OpenShift オブジェクトを定義します。

- Dev Workspace コントローラー

- Pod、サービス、永続ボリュームなど、Dev Workspace の実行に必要な OpenShift オブジェクトを作成して制御します。

- Dev Workspace カスタムリソース

- Dev Workspace 演算子があるクラスターでは、Dev Workspace カスタムリソース (CR) を作成することができます。Dev Workspace CR は、Devfile を OpenShift で表現したものです。OpenShift クラスター内の User ワークスペースを定義します。

関連情報

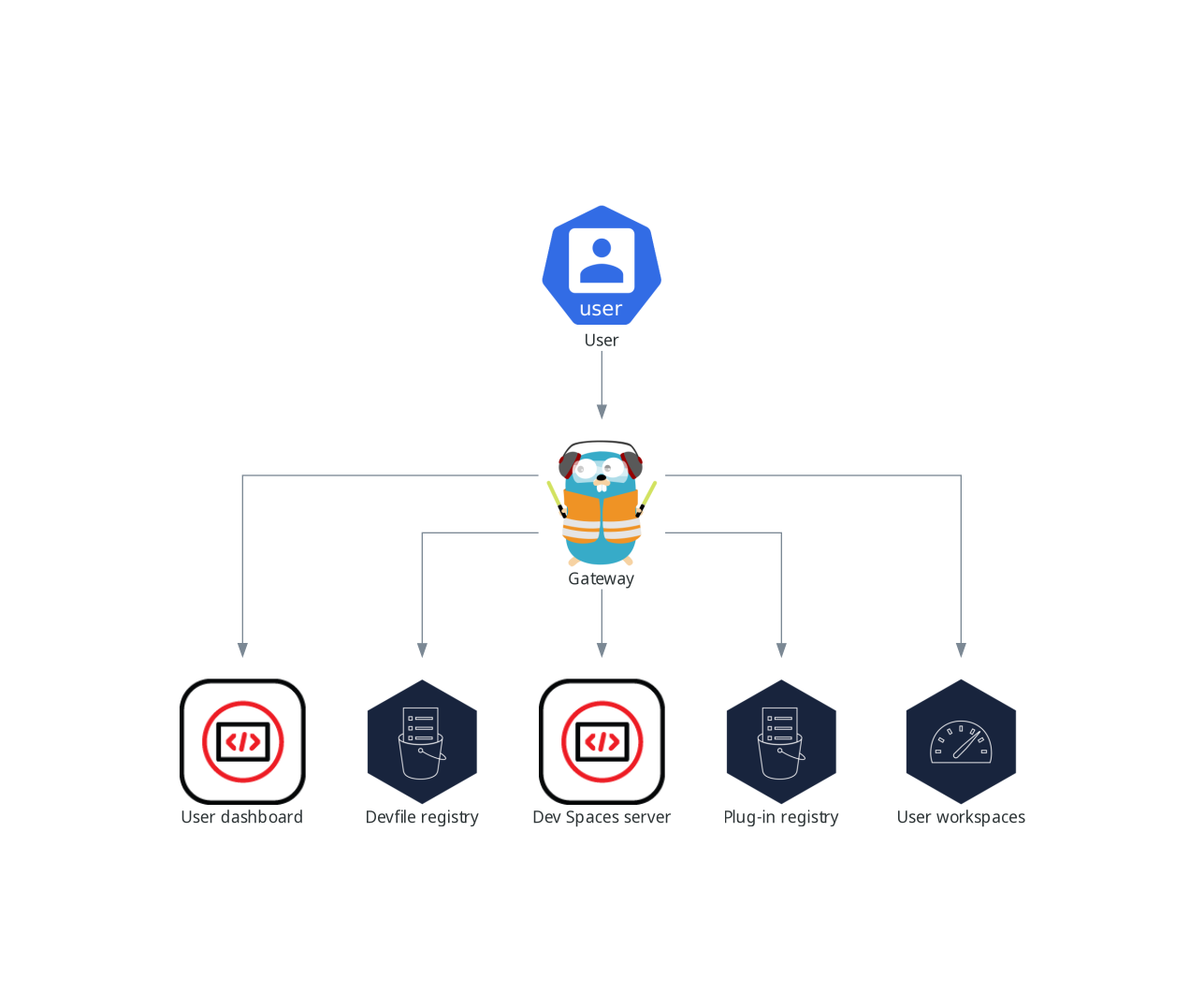

1.3.1.3. ゲートウェイ

OpenShift Dev Spaces ゲートウェイには、以下のロールがあります。

- 要求をルーティングする。Traefik を使用します。

- OpenID Connect(OIDC) でユーザーを認証する。OpenShift OAuth2 プロキシー を使用します。

- OpenShift RoleBased Access Control(RBAC) ポリシーを適用して、OpenShift Dev Spaces リソースへのアクセスを制御します。'kube-rbac-proxy' を使用します。

OpenShift Dev Spaces Operator はこれを che-gateway Deployment として管理します。

以下へのアクセスを制御します。

図1.3 OpenShift Dev Spaces ゲートウェイと他のコンポーネントとの対話

関連情報

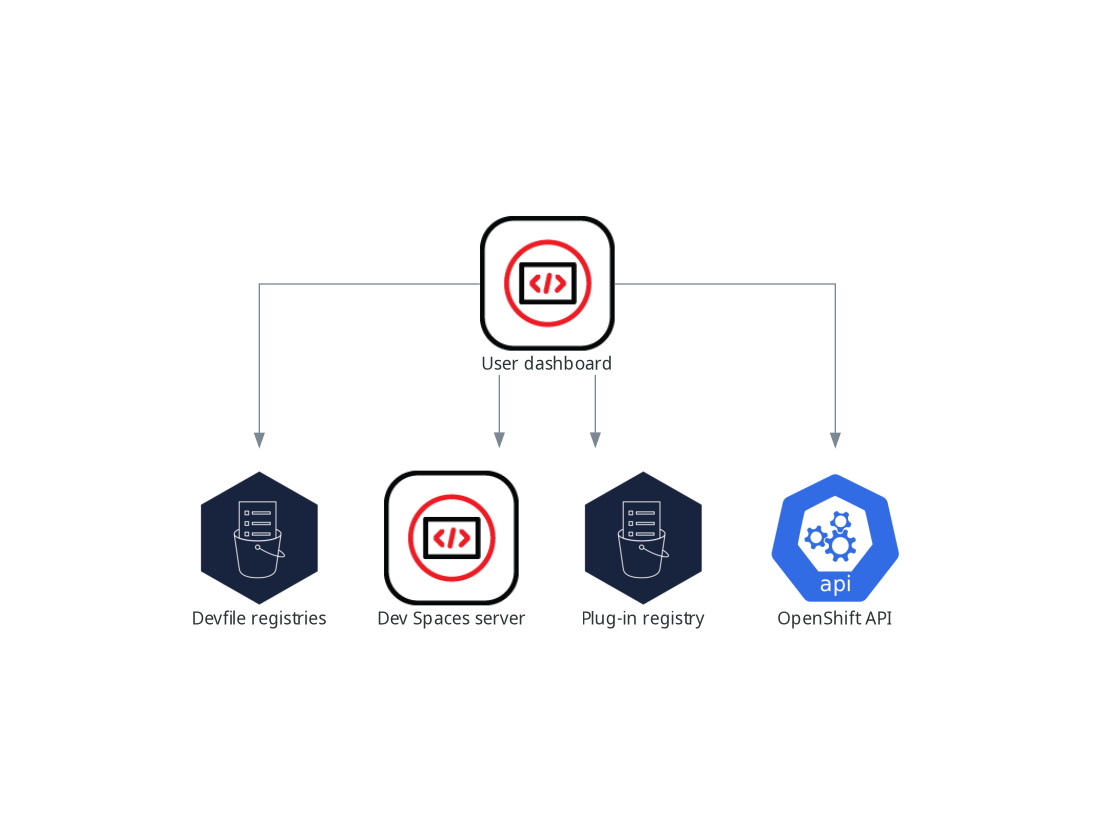

1.3.1.4. ユーザーダッシュボード

ユーザーダッシュボードは、Red Hat OpenShift Dev Spaces のランディングページです。OpenShift Dev Spaces ユーザーは、ユーザーダッシュボードを参照してワークスペースにアクセスし、管理します。これは React のアプリケーションです。OpenShift Dev Spaces デプロイメントは、devspaces-dashboard Deployment で起動します。

以下へのアクセス権が必要です。

- 「Devfile レジストリー」

- 「Dev Spaces サーバー」

- 「プラグインレジストリー」

- OpenShift API

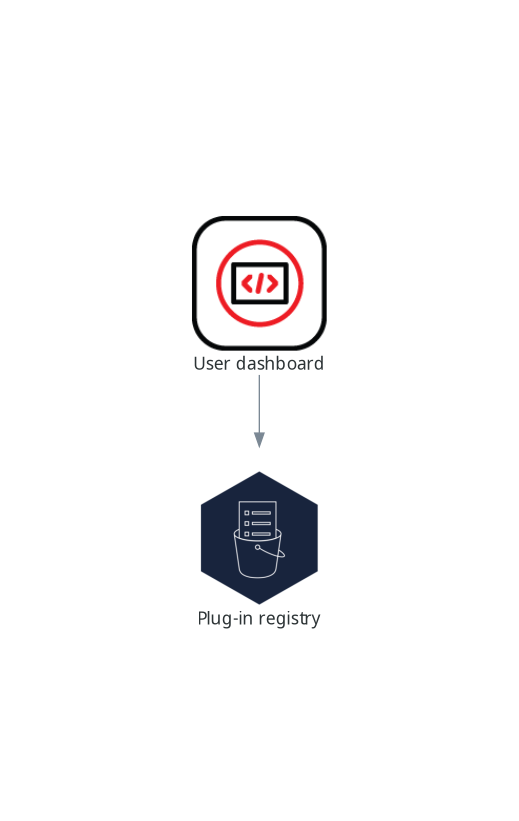

図1.4 User ダッシュボードと他のコンポーネントとの対話

ユーザーがユーザーダッシュボードにワークスペースの起動を要求すると、ユーザーダッシュボードはこの一連のアクションを実行します。

- ユーザーがコードサンプルからワークスペースを作成する際に、「Devfile レジストリー」 から devfile を収集します。

- リポジトリー URL を 「Dev Spaces サーバー」 に送信し、ユーザーがリモート devfile からワークスペースを作成する際に devfile が返されることを想定します。

- ワークスペースを記述した devfile を読み込みます。

- 「プラグインレジストリー」 から追加のメタデータを収集します。

- その情報を Dev Workspace Custom Resource に変換します。

- OpenShift API を使用して、ユーザープロジェクトに Dev Workspace Custom Resource を作成します。

- Dev Workspace Custom Resource のステータスを監視します。

- 実行中のワークスペース IDE にユーザーをリダイレクトします。

1.3.1.5. Devfile レジストリー

関連情報

OpenShift Dev Spaces devfile レジストリーは、すぐに使用できるワークスペースを作成するためのサンプル devfile のリストを提供するサービスです。「ユーザーダッシュボード」 は、Dashboard → Create Workspace ページにサンプルリストを表示します。各サンプルには、Devfile v2 が含まれています。OpenShift Dev Spaces デプロイメントでは、devfile-registry デプロイメントで 1 つの devfile レジストリーインスタンスを起動します。

図1.5 他のコンポーネントとの相互作用を登録する Devfile

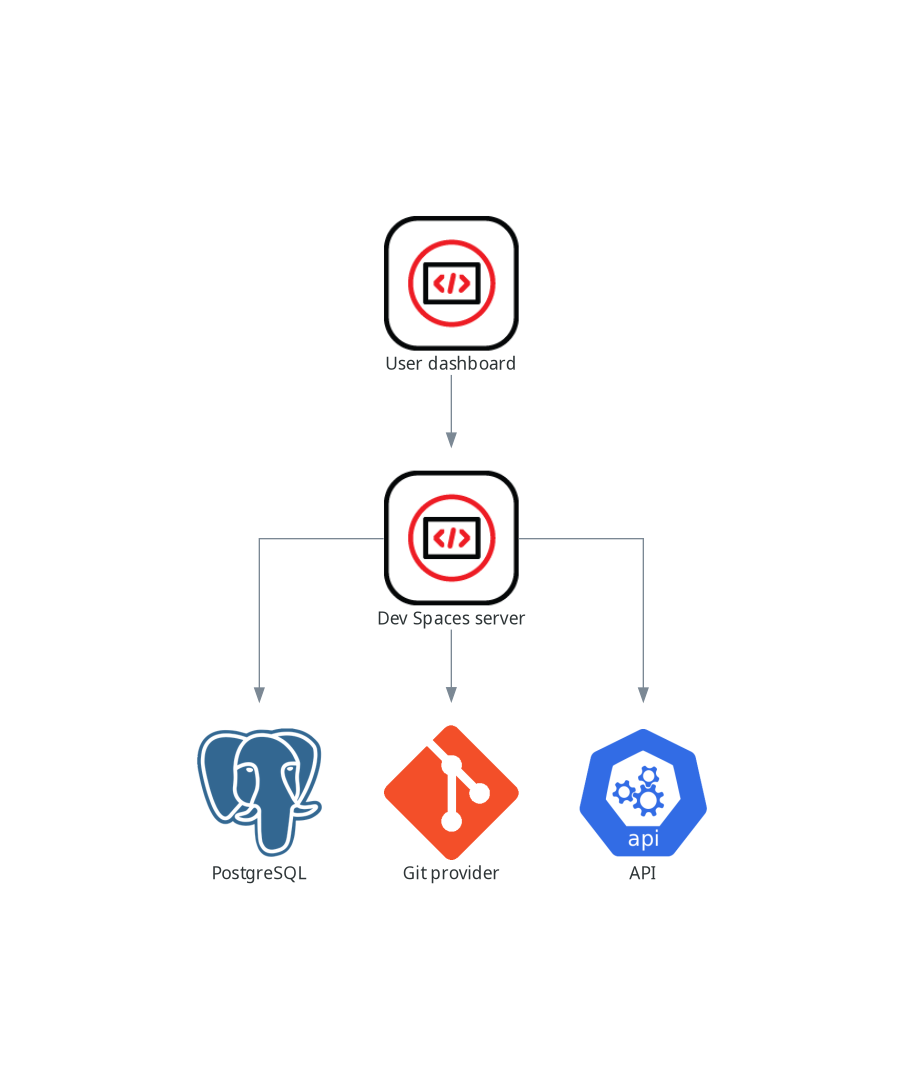

1.3.1.6. Dev Spaces サーバー

OpenShift Dev Spaces サーバーの主な機能は次のとおりです。

- ユーザーネームスペースの作成

- ユーザーネームスペースに必要なシークレットと Config Map のプロビジョニング

- Git サービスプロバイダーとの統合による devfile の取得および認証

OpenShift Dev Spaces サーバーは、HTTP REST API を公開する Java Web サービスで、以下へのアクセスが必要です。

- Git サービスプロバイダー

- OpenShift API

図1.6 OpenShift Dev Spaces サーバーと他のコンポーネントとの対話

1.3.1.7. プラグインレジストリー

各 OpenShift Dev Spaces ワークスペースは、特定のエディターおよび関連する拡張機能のセットで始まります。OpenShift Dev Spaces プラグインレジストリーは、利用可能なエディターおよびエディターエクステンションの一覧を提供します。各エディターや拡張機能については、Devfile v2 に記載されています。

「ユーザーダッシュボード」 は、レジストリーの内容を読み取っています。

図1.7 他のコンポーネントとのプラグインレジストリーの相互作用

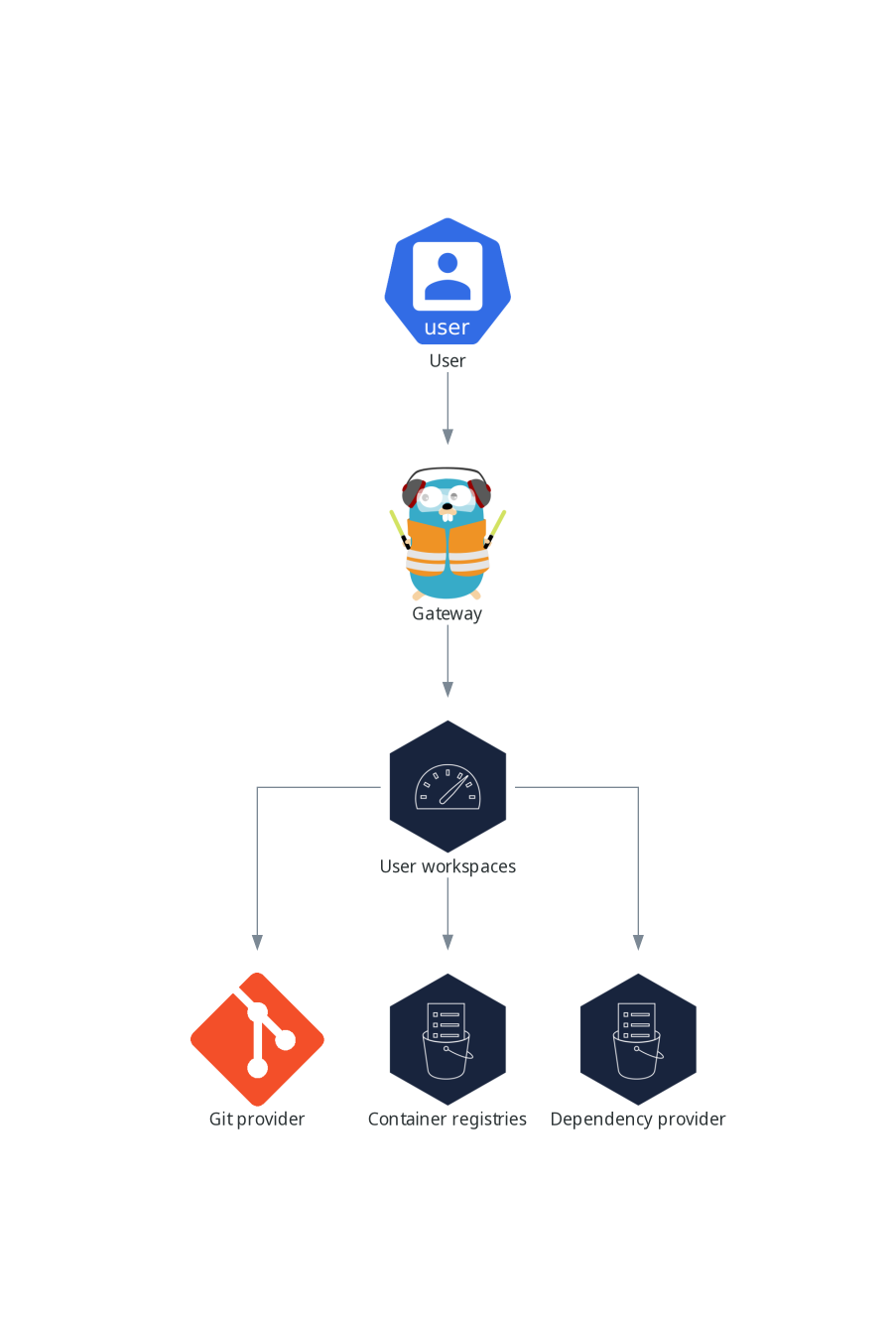

1.3.2. User ワークスペース

図1.8 User ワークスペースと他のコンポーネントとの対話

User ワークスペースは、コンテナー内で動作する Web IDE です。

User ワークスペースは、Web アプリケーションです。コンテナー内で動作するマイクロサービスで設定されており、ブラウザー上で動作する最新の IDE のすべてのサービスを提供します。

- エディター

- 言語オートコンプリート

- 言語サーバー

- デバッグツール

- プラグイン

- アプリケーションのランタイム

ワークスペースは、ワークスペースコンテナーと有効なプラグイン、および関連する OpenShift コンポーネントを含む 1 つの OpenShift Deployment です。

- コンテナー

- ConfigMap

- サービス

- エンドポイント

- ingress またはルート

- シークレット

- 永続ボリューム (PV)

OpenShift Dev Spaces ワークスペースには、OpenShift 永続ボリューム (PV) で永続化されるプロジェクトのソースコードが含まれます。マイクロサービスには、この共有ディレクトリーへの読み取り/書き込みアクセス権があります。

devfile v2 形式を使用して、OpenShift Dev Spaces ワークスペースのツールおよびランタイムアプリケーションを指定します。

以下の図は、OpenShift Dev Spaces ワークスペースとそのコンポーネントを実行する 1 つを示しています。

図1.9 OpenShift Dev Spaces ワークスペースコンポーネント

この図では、実行中のワークスペースが 1 つあります。

1.4. Dev Spaces リソース要件の計算

OpenShift Dev Spaces Operator、Dev Workspace Controller、およびユーザーワークスペースは Pod のセットで設定されます。Pod は、CPU とメモリーの制限と要求のリソース消費に影響します。

example devfile への次のリンクは、上流コミュニティーからの資料へのポインターです。この資料は、利用可能な最新のコンテンツと最新のベストプラクティスを表しています。これらのヒントは Red Hat の QE 部門によってまだ精査されておらず、広範なユーザーグループによってまだ証明されていません。この情報は慎重に使用してください。生産目的ではなく、教育および開発目的で使用するのが最適です。

手順

開発環境の定義に使用される devfile に依存するワークスペースのリソース要件を特定します。これには、devfile の

componentsセクションで明示的に指定されたワークスペースコンポーネントの識別が含まれます。以下は、次のコンポーネントを含む devfile の例 です。

例1.1

toolsdevfile の

toolsコンポーネントは、以下の要求および制限を定義します。memoryLimit: 6G memoryRequest: 512M cpuRequest: 1000m cpuLimit: 4000m例1.2

postgresqlpostgresqlコンポーネントはリクエストと制限を定義しないため、専用コンテナーのデフォルトに戻ります。memoryLimit: 128M memoryRequest: 64M cpuRequest: 10m cpuLimit: 1000mワークスペースの起動中、内部

che-gatewayコンテナーには次のリクエストと制限が暗黙的にプロビジョニングされます。memoryLimit: 256M memoryRequest: 64M cpuRequest: 50m cpuLimit: 500m

各ワークスペースに必要なリソースの合計を計算します。複数の devfile を使用する場合は、予想されるすべての devfile に対してこの計算を繰り返します。

例1.3 前の手順の example devfile のワークスペース要件

目的 Pod コンテナー名 メモリー制限 メモリー要求 CPU limit CPU request 開発者ツール

workspacetools6 GiB

512 MiB

4000 m

1000 m

Database

workspacepostgresql128 MiB

64 MiB

1000 m

10 m

OpenShift Dev Spaces ゲートウェイ

workspaceche-gateway256 MiB

64 MiB

500 m

50 m

Total

6.4 GiB

640 MiB

5500 m

1060 m

- ワークスペースごとに計算されたリソースに、すべてのユーザーが同時に実行すると予想されるワークスペースの数を掛けます。

OpenShift Dev Spaces Operator、オペランド、および Dev Workspace Controller の要件の合計を計算します。

表1.1 OpenShift Dev Spaces Operator、オペランド、および Dev Workspace Controller のデフォルト要件 目的 Pod の名前 コンテナー名 メモリー制限 メモリー要求 CPU limit CPU request OpenShift Dev Spaces 演算子

devspaces-operatordevspaces-operator256 MiB

64 MiB

500 m

100 m

OpenShift Dev Spaces Server

devspacesdevspaces-server1 GiB

512 MiB

1000 m

100 m

OpenShift Dev Spaces Dashboard

devspaces-dashboarddevspaces-dashboard256 MiB

32 MiB

500 m

100 m

OpenShift Dev Spaces Gateway

devspaces-gatewaytraefik4 GiB

128 MiB

1000 m

100 m

OpenShift Dev Spaces Gateway

devspaces-gatewayconfigbump256 MiB

64 MiB

500 m

50 m

OpenShift Dev Spaces Gateway

devspaces-gatewayoauth-proxy512 MiB

64 MiB

500 m

100 m

OpenShift Dev Spaces Gateway

devspaces-gatewaykube-rbac-proxy512 MiB

64 MiB

500 m

100 m

devfile レジストリー

devfile-registrydevfile-registry256 MiB

32 MiB

500 m

100 m

プラグインレジストリー

plugin-registryplugin-registry256 MiB

32 MiB

500 m

100 m

Dev Workspace Controller Manager

devworkspace-controller-managerdevworkspace-controller1 GiB

100 MiB

1000 m

250 m

Dev Workspace Controller Manager

devworkspace-controller-managerkube-rbac-proxy該当なし

該当なし

該当なし

該当なし

Dev Workspace Webhook Server

devworkspace-webhook-serverwebhook-server300 MiB

20 MiB

200 m

100 m

Dev Workspace Operator Catalog

devworkspace-operator-catalogregistry-server該当なし

50 MiB

該当なし

10 m

Dev Workspace Webhook Server

devworkspace-webhook-serverwebhook-server300 MiB

20 MiB

200 m

100 m

Dev Workspace Webhook Server

devworkspace-webhook-serverkube-rbac-proxy該当なし

該当なし

該当なし

該当なし

Total

9 GiB

1.2 GiB

6.9

1.3

第2章 Dev Spaces のインストール

このセクションでは、Red Hat OpenShift Dev Spaces をインストールする手順を説明します。

OpenShift Dev Spaces のインスタンスは、クラスターごとに 1 つだけデプロイできます。

2.1. クラウドでの Dev Spaces のインストール

Red Hat OpenShift Dev Spaces をクラウドでデプロイして実行します。

前提条件

- OpenShift Dev Spaces をデプロイする OpenShift クラスター。

-

dsc: Red Hat OpenShift Dev Spaces のコマンドラインツール。「dsc 管理ツールのインストール」 を参照してください。

2.1.1. クラウドでの OpenShift Dev Spaces のデプロイ

dsc ツールを使用してクラウドで OpenShift Dev Spaces Server を起動するには、以下の手順に従ってください。

2.1.2. CLI を使用して OpenShift に Dev Spaces をインストールする

OpenShift Dev Spaces を OpenShift にインストールできます。

前提条件

- OpenShift Container Platform

-

OpenShift クラスターへの管理権限を持つアクティブな

ocセッション。OpenShift CLI の使用開始を 参照してください。 -

dsc。「dsc 管理ツールのインストール」 を参照してください。

手順

オプション: この OpenShift クラスターに OpenShift Dev Spaces をデプロイした場合は、以前の OpenShift Dev Spaces インスタンスが削除されていることを確認してください。

$ dsc server:delete

OpenShift Dev Spaces インスタンスを作成します。

$ dsc server:deploy --platform openshift

検証手順

OpenShift Dev Spaces インスタンスのステータスを確認します。

$ dsc server:status

OpenShift Dev Spaces クラスターインスタンスに移動します。

$ dsc dashboard:open

2.1.3. Web コンソールを使用して OpenShift に Dev Spaces をインストールする

コマンドラインで OpenShift Dev Spaces をインストール できない場合は、OpenShift Web コンソールからインストールできます。

前提条件

- クラスター管理者による OpenShift Web コンソールセッション。Web コンソールへのアクセスを 参照してください。

-

OpenShift クラスターへの管理権限を持つアクティブな

ocセッション。OpenShift CLI の使用開始を 参照してください。 - 同じ OpenShift クラスターに繰り返しインストールする場合は、7章Dev Spaces のアンインストール に従って、以前の OpenShift Dev Spaces インスタンスをアンインストールしました。

手順

-

OpenShift Web コンソールの 管理者 ビューで、Operators → OperatorHub に移動し、

Red Hat OpenShift Dev Spacesを検索します。 Red Hat OpenShift Dev Spaces Operator をインストールします。

ヒントWeb コンソールを使用して OperatorHub からインストールするを 参照してください。

注意Red Hat OpenShift Dev Spaces Operator は、Dev Workspace Operator に依存します。Red Hat OpenShift Dev Spaces Operator を手動でデフォルト以外の namespace にインストールする場合は、Dev Workspace Operator も同じ namespace にインストールされていることを確認してください。これは、Operator Lifecycle Manager が、Red Hat OpenShift Dev Spaces Operator namespace 内の依存関係として Dev Workspace Operator をインストールしようとすることから、Red Hat OpenShift Dev Spaces Operator が別の namespace にインストールされている場合は、Dev Workspace Operator は 2 つの競合するインストールとなる可能性があるため、確認が必要となります。

クラスターに Web Terminal Operator を オンボードする場合は、両方とも Dev Workspace Operator に依存しているため、Red Hat OpenShift Dev Spaces Operator と同じインストール名前空間を使用するようにしてください。Web Terminal Operator、Red Hat OpenShift Dev Spaces Operator、および Dev Workspace Operator は、同じ名前空間にインストールする必要があります。

次のように、OpenShift で

openshift-devspacesプロジェクトを作成します。oc create namespace openshift-devspaces

- Operators → Installed Operators → Red Hat OpenShift Dev Spaces インスタンスの仕様 → Create CheCluster → YAML view に移動します。

-

YAML view で、

namespace: openshift-operatorsをnamespace: openshift-devspacesに置き換えます。 Create を選択します。

ヒントインストールされた Operators からアプリケーションを作成するを 参照してください。

検証

- Red Hat OpenShift Dev Spaces インスタンスの仕様 で、devspaces に移動し、Details タブに移動します。

- Message の下に None があることを確認します。これはエラーがないことを意味します。

- Red Hat OpenShift Dev Spaces URL で、OpenShift Dev Spaces インスタンスの URL が表示されるまで待ち、URL を開いて OpenShift Dev Spaces ダッシュボードを確認します。

- Resources タブで、OpenShift Dev Spaces デプロイメントのリソースとそのステータスを表示します。

2.1.4. 制限された環境での Dev Spaces のインストール

制限されたネットワークで動作する OpenShift クラスターでは、パブリックリソースは利用できません。

ただし、OpenShift Dev Spaces をデプロイしてワークスペースを実行するには、以下のパブリックリソースが必要です。

- Operator カタログ

- コンテナーイメージ

- サンプルプロジェクト

これらのリソースを使用可能にするには、OpenShift クラスターからアクセス可能なレジストリー内のそれらのコピーに置き換えます。

前提条件

- OpenShift クラスターに、少なくとも 64 GB のディスクスペースがある。

- OpenShift クラスターは制限されたネットワーク上で動作する準備ができており、OpenShift コントロールプレーンはパブリックインターネットにアクセスできる。切断されたインストールのミラーリングについて および 制限されたネットワークでの Operator Lifecycle Manager の使用を 参照してください。

-

OpenShift クラスターへの管理権限を持つアクティブな

ocセッション。OpenShift CLI の使用開始を 参照してください。 -

registry.redhat.ioRed Hat エコシステムカタログへのアクティブなocレジストリーセッション。Red Hat Container Registry authentication を参照してください。

-

opm。opmCLI のインストールを 参照してください。 -

jq。Downloadingjqを参照してください。 -

podman。Podman Installation Instructions を参照してください。 -

skopeoバージョン 1.6 以降。Installing Skopeo を参照してください。 -

プライベート Docker レジストリーへの管理アクセス権を持つアクティブな

skopeoセッション。レジストリーへの認証、および 切断されたインストール用のイメージのミラーリング。 -

OpenShift Dev Spaces バージョン 3.12 用の

dsc。「dsc 管理ツールのインストール」 を参照してください。

手順

ミラーリングスクリプトをダウンロードして実行し、カスタム Operator カタログをインストールし、関連するイメージをミラーリングします (prepare-restricted-environment.sh)。

$ bash prepare-restricted-environment.sh \ --devworkspace_operator_index registry.redhat.io/redhat/redhat-operator-index:v4.15\ --devworkspace_operator_version "v0.26.0" \ --prod_operator_index "registry.redhat.io/redhat/redhat-operator-index:v4.15" \ --prod_operator_package_name "devspaces" \ --prod_operator_bundle_name "devspacesoperator" \ --prod_operator_version "v3.12.0" \ --my_registry "<my_registry>" 1

- 1

- イメージがミラーリングされるプライベート Docker レジストリー

前の手順で

で che-operator-cr-patch.yamlに指定した設定で OpenShift Dev Spaces をインストールします。$ dsc server:deploy \ --platform=openshift \ --olm-channel stable \ --catalog-source-name=devspaces-disconnected-install \ --catalog-source-namespace=openshift-marketplace \ --skip-devworkspace-operator \ --che-operator-cr-patch-yaml=che-operator-cr-patch.yaml

- OpenShift Dev Spaces namespace からユーザープロジェクト内のすべての Pod への受信トラフィックを許可します。「ネットワークポリシーの設定」 を参照してください。

2.1.4.1. Ansible サンプルのセットアップ

制限された環境で Ansible サンプルを使用するには、次の手順に従います。

前提条件

- Microsoft Visual Studio Code - オープンソース IDE

- 64 ビット x86 システム

手順

以下のイメージをミラーリングします。

quay.io/devspaces/ansible-creator-ee@sha256:3ff5d2d5f17c9c1e4a352d9922e27be09641647ac028a56845aaab6f6e3c7958 quay.io/devspaces/ansible-creator-ee@sha256:04c7aa48f34ab28dc21f36acfe472b249f29c24d1a52d98b2c8da75dd6587d79

以下のドメインへのアクセスを許可するようにクラスタープロキシーを設定します。

.ansible.com .ansible-galaxy-ng.s3.dualstack.us-east-1.amazonaws.com

以下の IDE および CPU アーキテクチャーのサポートは、今後のリリースで計画されています。

IDE

- JetBrains IntelliJ IDEA Community Edition IDE (テクノロジープレビュー)

CPU アーキテクチャー

- IBM Power (ppc64le)

- IBM Z (s390x)

2.2. 完全修飾ドメイン名 (FQDN) の検索

組織の OpenShift Dev Spaces インスタンスの完全修飾ドメイン名 (FQDN) は、コマンドラインまたは OpenShift Web コンソールで取得できます。

次のように、OpenShift Web コンソールの Administrator ビューで、組織の OpenShift Dev Spaces インスタンスの FQDN を見つけることができます。Operator → Installed Operators → Red Hat OpenShift Dev Spaces インスタンスの仕様 → devspaces → Red Hat OpenShift Dev Spaces URL に移動します。

前提条件

-

OpenShift クラスターへの管理権限を持つアクティブな

ocセッション。OpenShift CLI の使用開始を 参照してください。

手順

以下のコマンドを実行します。

oc get checluster devspaces -n openshift-devspaces -o jsonpath='{.status.cheURL}'

第3章 Dev Spaces の設定

このセクションでは、Red Hat OpenShift Dev Spaces の設定方法とオプションについて説明します。

3.1. CheCluster カスタムリソースについて

OpenShift Dev Spaces のデフォルトデプロイメントは、Red Hat OpenShift Dev Spaces Operator で定義される CheCluster カスタムリソースパラメーターで設定されます。

CheCluster カスタムリソースは Kubernetes オブジェクトです。CheCluster カスタムリソース YAML ファイルを編集して設定できます。このファイルには、各コンポーネント (devWorkspace、cheServer、pluginRegistry、devfileRegistry、dashboard および imagePuller) を設定するセクションが含まれています。

Red Hat OpenShift Dev Spaces Operator は、CheCluster カスタムリソースを OpenShift Dev Spaces インストールの各コンポーネントで使用できる Config Map に変換します。

OpenShift プラットフォームは、設定を各コンポーネントに適用し、必要な Pod を作成します。OpenShift がコンポーネントの設定で変更を検知すると、Pod を適宜再起動します。

例3.1 OpenShift Dev Spaces サーバーコンポーネントの主なプロパティーの設定

-

cheServerコンポーネントセクションで適切な変更を加えたCheClusterカスタムリソース YAML ファイルを適用します。 -

Operator は、

cheConfigMapを生成します。 -

OpenShift は

ConfigMapの変更を検出し、OpenShift Dev Spaces Pod の再起動をトリガーします。

3.1.1. dsc を使用したインストール時に CheCluster カスタムリソースの設定

適切な設定で OpenShift Dev Space をデプロイするには、OpenShift Dev Space のインストール時に CheCluster カスタムリソース YAML ファイルを編集します。それ以外の場合は、OpenShift Dev Spaces デプロイメントは Operator で設定されたデフォルト設定パラメーターを使用します。

前提条件

-

OpenShift クラスターへの管理権限を持つアクティブな

ocセッション。CLI の使用開始を 参照してください。 -

dsc。「dsc 管理ツールのインストール」 を参照してください。

手順

設定する

CheClusterカスタムリソースのサブセットを含むche-operator-cr-patch.yamlYAML ファイルを作成します。spec: <component>: <property_to_configure>: <value>

OpenShift Dev Spaces をデプロイし、

che-operator-cr-patch.yamlファイルで説明されている変更を適用します。$ dsc server:deploy \ --che-operator-cr-patch-yaml=che-operator-cr-patch.yaml \ --platform <chosen_platform>

検証

設定されたプロパティーの値を確認します。

$ oc get configmap che -o jsonpath='{.data.<configured_property>}' \ -n openshift-devspaces

3.1.2. CLI を使用して CheCluster カスタムリソースの設定

OpenShift Dev Spaces の実行中のインスタンスを設定するには、CheCluster カスタムリソース YAML ファイルを編集します。

前提条件

- OpenShift 上の OpenShift Dev Spaces のインスタンス。

-

宛先 OpenShift クラスターへの管理権限を持つアクティブな

ocセッション。CLI の使用開始を 参照してください。

手順

クラスター上の CheCluster カスタムリソースを編集します。

$ oc edit checluster/devspaces -n openshift-devspaces

- ファイルを保存して閉じ、変更を適用します。

検証

設定されたプロパティーの値を確認します。

$ oc get configmap che -o jsonpath='{.data.<configured_property>}' \ -n openshift-devspaces

3.1.3. CheCluster カスタムリソースフィールドの参照

このセクションでは、CheCluster カスタムリソースのカスタマイズに使用できるすべてのフィールドについて説明します。

例3.2 最小の CheCluster カスタムリソースの例。

apiVersion: org.eclipse.che/v2

kind: CheCluster

metadata:

name: devspaces

namespace: openshift-devspaces

spec:

components: {}

devEnvironments: {}

networking: {}| プロパティー | 説明 | デフォルト |

|---|---|---|

| containerBuildConfiguration | コンテナーのビルド設定。 | |

| defaultComponents | DevWorkspaces に適用されるデフォルトコンポーネント。デフォルトコンポーネントは、Devfile にコンポーネントが含まれていない場合に使用します。 | |

| defaultEditor |

一緒に作成するワークスペースのデフォルトエディター。プラグイン ID または URI を指定できます。プラグイン ID には | |

| defaultNamespace | ユーザーのデフォルトの namespace。 | { "autoProvision": true, "template": "<username>-che"} |

| defaultPlugins | DevWorkspaces に適用されるデフォルトのプラグイン。 | |

| deploymentStrategy |

DeploymentStrategy は、既存のワークスペース Pod を新しい Pod に置き換えるために使用するデプロイメントストラテジーを定義します。利用可能なデプロイメントは | |

| disableContainerBuildCapabilities |

コンテナービルド機能を無効にします。 | |

| gatewayContainer | GatewayContainer の設定。 | |

| imagePullPolicy | imagePullPolicy は、DevWorkspace のコンテナーに使用される imagePullPolicy を定義します。 | |

| maxNumberOfRunningWorkspacesPerUser | ユーザーごとの実行中のワークスペースの最大数。値 -1 を指定すると、ユーザーはワークスペースを無制限に実行できます。 | |

| maxNumberOfWorkspacesPerUser | ユーザーが保持できる停止中と実行中の両方のワークスペースの総数。値 -1 を指定すると、ユーザーはワークスペースを無制限に保持できます。 | -1 |

| nodeSelector | ノードセレクターは、ワークスペース Pod を実行できるノードを制限します。 | |

| persistUserHome | persistUserHome は、ワークスペースでユーザーのホームディレクトリーを永続化するための設定オプションを定義します。 | |

| podSchedulerName | ワークスペース Pod の Pod スケジューラー。指定しない場合、Pod スケジューラーはクラスターのデフォルトのスケジューラーに設定されます。 | |

| projectCloneContainer | プロジェクトクローンコンテナーの設定。 | |

| secondsOfInactivityBeforeIdling | ワークスペースのアイドルタイムアウト (秒単位)。このタイムアウトは、アクティビティーがない場合にワークスペースがアイドル状態になるまでの期間です。非アクティブによるワークスペースのアイドリングを無効にするには、この値を -1 に設定します。 | 1800 |

| secondsOfRunBeforeIdling | ワークスペースのタイムアウトを秒単位で実行します。このタイムアウトは、ワークスペースが実行される最大期間です。ワークスペースの実行タイムアウトを無効にするには、この値を -1 に設定します。 | -1 |

| security | ワークスペースのセキュリティー設定。 | |

| serviceAccount | ワークスペースの開始時に DevWorkspace オペレーターが使用する ServiceAccount。 | |

| serviceAccountTokens | 投影されたボリュームとしてワークスペース Pod にマウントされる ServiceAccount トークンのリスト。 | |

| startTimeoutSeconds | StartTimeoutSeconds は、ワークスペースが自動的に失敗するまでの開始にかかる最大期間 (秒単位) を決定します。指定しない場合、デフォルト値の 300 秒 (5 分) が使用されます。 | 300 |

| ストレージ | ワークスペースの永続ストレージ。 | { "pvcStrategy": "per-user"} |

| tolerations | ワークスペース Pod の Pod 許容範囲によって、ワークスペース Pod を実行できる場所が制限されます。 | |

| trustedCerts | 信頼できる証明書の設定。 | |

| user | ユーザー設定 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| autoProvision | ユーザー namespace の自動作成を許可するかどうかを示します。false に設定すると、クラスター管理者がユーザー namespace を事前に作成する必要があります。 | true |

| テンプレート |

ユーザー namespace を事前に作成しない場合には、このフィールドは最初のワークスペースの起動時に作成される Kubernetes namespace を定義します。che-workspace-<username> など、 | "<username>-che" |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| editor | デフォルトのプラグインを指定するエディター ID。 | |

| plugins | 指定されたエディターのデフォルトのプラグイン URI。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| env | コンテナーに設定する環境変数のリスト。 | |

| image | コンテナーイメージ。Operator によって提供されるデフォルトのコンテナーイメージを使用するには、これを省略するか、空のままにします。 | |

| imagePullPolicy |

イメージプルポリシーデフォルト値は、 | |

| name | コンテナー名 | |

| resources | このコンテナーに必要なコンピューティングリソース。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| perUserStrategyPvcConfig |

| |

| perWorkspaceStrategyPvcConfig |

| |

| pvcStrategy |

OpenShift Dev Spaces サーバーの永続ボリューム要求ストラテジー。サポートされているストラテジーは、 | "per-user" |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| claimSize | Persistent Volume Claim のサイズ。要求サイズを更新するには、要求サイズをプロビジョニングするストレージクラスがサイズ変更をサポートしている必要があります。 | |

| storageClass | Persistent Volume Claim のストレージクラス。省略されるか、空のままの場合は、デフォルトのストレージクラスが使用されます。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| claimSize | Persistent Volume Claim のサイズ。要求サイズを更新するには、要求サイズをプロビジョニングするストレージクラスがサイズ変更をサポートしている必要があります。 | |

| storageClass | Persistent Volume Claim のストレージクラス。省略されるか、空のままの場合は、デフォルトのストレージクラスが使用されます。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| gitTrustedCertsConfigMapName |

ConfigMap には、OpenShift Dev Spaces コンポーネントに伝播し、Git に特定の設定を提供するための証明書が含まれています。次のページを参照してください: https://www.eclipse.org/che/docs/stable/administration-guide/deploying-che-with-support-for-git-repositories-with-self-signed-certificates/ ConfigMap には、 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| openShiftSecurityContextConstraint | コンテナーを構築するための OpenShift セキュリティーコンテキスト制約。 | "container-build" |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| cheServer | OpenShift Dev Spaces サーバーに関連する一般的な設定。 | { "debug": false, "logLevel": "INFO"} |

| dashboard | OpenShift Dev Spaces インストールで使用されるダッシュボードに関連する設定。 | |

| devWorkspace | DevWorkspace Operator の設定。 | |

| devfileRegistry | OpenShift Dev Spaces インストールで使用される Devfile レジストリーに関連する設定。 | |

| imagePuller | Kubernetes Image Puller の設定。 | |

| metrics | OpenShift Dev Spaces サーバーのメトリック設定。 | { "enable": true} |

| pluginRegistry | OpenShift Dev Spaces インストールで使用されるプラグインレジストリーに関連する設定。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| clusterRoles |

OpenShift Dev Spaces ServiceAccount に割り当てられた追加の ClusterRoles。各ロールには、 | |

| debug | OpenShift Dev Spaces サーバーのデバッグモードを有効にします。 | false |

| デプロイメント | デプロイメントオーバーライドオプション。 | |

| extraProperties |

| |

| logLevel |

OpenShift Dev Spaces サーバーのログレベル: | "INFO" |

| proxy | Kubernetes クラスターのプロキシーサーバー設定。OpenShift クラスターに追加の設定は必要ありません。これらの設定を OpenShift クラスターに指定することで、OpenShift プロキシー設定をオーバーライドします。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| credentialsSecretName |

プロキシーサーバーの | |

| nonProxyHosts |

プロキシーをバイパスして直接アクセスできるホストのリスト。ワイルドカードドメインを指定するには、次の形式 | |

| port | プロキシーサーバーポート。 | |

| url |

プロキシーサーバーの URL (プロトコル + ホスト名)。プロキシー設定が必要な場合にのみ使用してください。Operator は OpenShift クラスター全体のプロキシー設定を尊重し、カスタムリソースで |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| デプロイメント | デプロイメントオーバーライドオプション。 | |

| disableInternalRegistry | 内部プラグインレジストリーを無効にします。 | |

| externalPluginRegistries | 外部プラグインレジストリー。 | |

| openVSXURL | VSX レジストリー URL を開きます。省略した場合は、埋め込みインスタンスが使用されます。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| url | プラグインレジストリーのパブリック URL。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| デプロイメント | デプロイメントオーバーライドオプション。 | |

| disableInternalRegistry | 内部 devfile レジストリーを無効にします。 | |

| externalDevfileRegistries | サンプルのすぐに使用できる devfile を提供する外部 devfile レジストリー。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| url | すぐに使用できるサンプルの devfile を提供する devfile レジストリーのパブリック UR。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| branding | Dashboard のブランディングリソース | |

| デプロイメント | デプロイメントオーバーライドオプション。 | |

| headerMessage | ダッシュボードのヘッダーメッセージ。 | |

| logLevel | ダッシュボードのログレベル。 | "ERROR" |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| 表示 | ダッシュボードにメッセージを表示するように指示します。 | |

| text | ユーザーダッシュボードに表示される警告メッセージ。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| enable |

コミュニティーでサポートされている Kubernetes Image Puller Operator をインストールして設定します。仕様を指定せずに値を | |

| spec | CheCluster で Image Puller を設定するための Kubernetes Image Puller 仕様。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| enable |

OpenShift Dev Spaces サーバーエンドポイントの | true |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| azure | ユーザーが Azure DevOps Service (dev.azure.com) でホストされているリポジトリーを操作できるようにします。 | |

| bitbucket | ユーザーが Bitbucket でホストされているリポジトリー (bitbucket.org または自己ホスト型) を操作できるようにします。 | |

| github | ユーザーが GitHub (github.com または GitHub Enterprise) でホストされているリポジトリーを操作できるようにします。 | |

| gitlab | ユーザーが GitLab (gitlab.com または自己ホスト型) でホストされているリポジトリーを操作できるようにします。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| disableSubdomainIsolation |

サブドメイン分離を無効にします。 | |

| endpoint |

GitHub サーバーのエンドポイント URL。 | |

| secretName | Kubernetes シークレット。Base64 でエンコードされた GitHub OAuth クライアント ID と GitHub OAuth クライアントシークレットが含まれます。詳細については、次のページを参照してください: https://www.eclipse.org/che/docs/stable/administration-guide/cconfiguring-oauth-2-for-github/ |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| endpoint |

GitLab サーバーのエンドポイント URL。 | |

| secretName | Kubernetes シークレット。Base64 でエンコードされた GitHub アプリケーション ID と GitLab アプリケーションクライアントシークレットが含まれます。次のページを参照してください: https://www.eclipse.org/che/docs/stable/administration-guide/cconfiguring-oauth-2-for-gitlab/。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| endpoint |

Bitbucket サーバーのエンドポイント URL。 | |

| secretName | Kubernetes シークレット。Base64 でエンコードされた Bitbucket OAuth 1.0 または OAuth 2.0 データが含まれます。詳細は、https://www.eclipse.org/che/docs/stable/administration-guide/configuring-oauth-1-for-a-bitbucket-server/ および https://www.eclipse.org/che/docs/stable/administration-guide/configuring-oauth-2-for-the-bitbucket-cloud/ を参照してください。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| secretName | Kubernetes シークレット。Base64 でエンコードされた Azure DevOps Service アプリケーション ID とクライアントシークレットが含まれます。次のページを参照してください: https://www.eclipse.org/che/docs/stable/administration-guide/cconfiguring-oauth-2-for-microsoft-azure-devops-services |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| annotations | Ingress (OpenShift プラットフォームのルート) に設定されるアノテーションを定義します。Kubernetes プラットフォームのデフォルトは次のとおりです: kubernetes.io/ingress.class: "nginx" nginx.ingress.kubernetes.io/proxy-read-timeout: "3600"、nginx.ingress.kubernetes.io/proxy-connect-timeout: "3600"、nginx.ingress.kubernetes.io/ssl-redirect: "true" | |

| auth | 認証設定 | { "gateway": { "configLabels": { "app": "che", "component": "che-gateway-config" } }} |

| domain | OpenShift クラスターの場合、Operator はドメインを使用してルートのホスト名を生成します。生成されたホスト名は、che-<devspaces-namespace>.<domain> のパターンに従います。<devspaces-namespace> は、CheCluster CRD が作成される namespace です。ラベルと組み合わせて、デフォルト以外の Ingress Controller によって提供されるルートを作成します。Kubernetes クラスターの場合、グローバル Ingress ドメインが含まれます。デフォルト値はありません。指定する必要があります。 | |

| hostname | インストールされた OpenShift Dev Spaces サーバーのパブリックホスト名。 | |

| ingressClassName |

IngressClassName は、IngressClass クラスターリソースの名前です。クラス名が | |

| labels | Ingress (OpenShift プラットフォームのルート) に設定されるラベルを定義します。 | |

| tlsSecretName |

Ingress TLS ターミネーションのセットアップに使用されるシークレットの名前。フィールドが空の文字列の場合、デフォルトのクラスター証明書が使用されます。シークレットには、 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| advancedAuthorization |

高度な承認設定。Che へのアクセスを許可するユーザーとグループを決定します。ユーザーは、 | |

| gateway | ゲートウェイ設定。 | { "configLabels": { "app": "che", "component": "che-gateway-config" }} |

| identityProviderURL | アイデンティティープロバイダーサーバーの公開 URL。 | |

| identityToken |

アップストリームに渡される ID トークン。サポートされるトークンには、 | |

| oAuthAccessTokenInactivityTimeoutSeconds |

OpenShift 側で ID フェデレーションをセットアップするために使用される OpenShift | |

| oAuthAccessTokenMaxAgeSeconds |

OpenShift 側で ID フェデレーションをセットアップするために使用される OpenShift | |

| oAuthClientName |

OpenShift 側でアイデンティティーフェデレーションを設定するために使用される OpenShift | |

| oAuthScope | アクセストークンのスコープ。このフィールドは、Kubernetes 専用に作成された OpenShift Dev Spaces インストールに固有であり、OpenShift では無視されます。 | |

| oAuthSecret |

OpenShift 側でアイデンティティーフェデレーションを設定するために使用される OpenShift |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| configLabels | ゲートウェイ設定ラベル。 | { "app": "che", "component": "che-gateway-config"} |

| デプロイメント |

デプロイメントオーバーライドオプション。ゲートウェイのデプロイメントは複数のコンテナーで設定されているため、設定では次の名前で区別する必要があります。 | |

| kubeRbacProxy | OpenShift Dev Spaces ゲートウェイ Pod 内の kube-rbac-proxy の設定。 | |

| oAuthProxy | OpenShift Dev Spaces ゲートウェイ Pod 内の oauth-proxy の設定。 | |

| traefik | OpenShift Dev Spaces ゲートウェイ Pod 内の Traefik の設定。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| hostname | イメージのプルに使用する別のコンテナーレジストリーの任意のホスト名または URL。この値は、OpenShift Dev Spaces デプロイメントに含まれるすべてのデフォルトのコンテナーイメージで定義されたコンテナーレジストリーのホスト名をオーバーライドします。これは、制限された環境で OpenShift Dev Spaces をインストールする場合にとくに役立ちます。 | |

| 組織 | イメージのプルに使用する別のレジストリーのオプションのリポジトリー名。この値は、OpenShift Dev Spaces デプロイメントに含まれるすべてのデフォルトのコンテナーイメージで定義されたコンテナーレジストリー組織をオーバーライドします。これは、制限された環境で OpenShift Dev Spaces をインストールする場合にとくに役立ちます。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| コンテナー | Pod に属するコンテナーのリスト。 | |

| securityContext | Pod を実行する必要があるセキュリティーオプション。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| env | コンテナーに設定する環境変数のリスト。 | |

| image | コンテナーイメージ。Operator によって提供されるデフォルトのコンテナーイメージを使用するには、これを省略するか、空のままにします。 | |

| imagePullPolicy |

イメージプルポリシーデフォルト値は、 | |

| name | コンテナー名 | |

| resources | このコンテナーに必要なコンピューティングリソース。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| limits | 許可されるコンピューティングリソースの最大量について説明します。 | |

| request | 必要なコンピューティングリソースの最小量について説明します。 |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| cpu |

CPU、コア単位。(500m = 0.5 コア) 値が指定されていない場合は、コンポーネントに応じてデフォルト値が設定されます。値が | |

| memory |

メモリー (バイト単位)。(500Gi = 500GiB = 500 * 1024 * 1024 * 1024) 値が指定されていない場合は、コンポーネントに応じてデフォルト値が設定されます。値が |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| cpu |

CPU、コア単位。(500m = 0.5 コア) 値が指定されていない場合は、コンポーネントに応じてデフォルト値が設定されます。値が | |

| memory |

メモリー (バイト単位)。(500Gi = 500GiB = 500 * 1024 * 1024 * 1024) 値が指定されていない場合は、コンポーネントに応じてデフォルト値が設定されます。値が |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| fsGroup |

Pod の全コンテナーに適用される特別な補助グループです。デフォルト値は | |

| runAsUser |

コンテナープロセスのエントリーポイントを実行するための UID。デフォルト値は |

| プロパティー | 説明 | デフォルト |

|---|---|---|

| chePhase | OpenShift Dev Spaces デプロイメントの現在のフェーズを指定します。 | |

| cheURL | OpenShift Dev Spaces サーバーのパブリック URL。 | |

| cheVersion | 現在インストールされている OpenShift Dev Spaces のバージョン。 | |

| devfileRegistryURL | 内部 devfile レジストリーの公開 URL。 | |

| gatewayPhase | ゲートウェイデプロイメントの現在のフェーズを指定します。 | |

| message | OpenShift Dev Spaces デプロイメントが現在のフェーズにある理由の詳細を示す、人間が判読できるメッセージ。 | |

| pluginRegistryURL | 内部プラグインレジストリーの公開 URL。 | |

| reason | OpenShift Dev Spaces デプロイメントが現在のフェーズにある理由の詳細を示す簡単な CamelCase メッセージ。 | |

| workspaceBaseDomain | 解決されたワークスペースベースドメイン。これは、仕様で明示的に定義された同じ名前のプロパティーのコピーか、仕様で定義されておらず、OpenShift で実行している場合は、ルートの自動的に解決されたベースドメインです。 |

3.2. プロジェクトの設定

OpenShift Dev Spaces は、ユーザーごとに、プロジェクト内のワークスペースを分離します。OpenShift Dev Spaces は、ラベルとアノテーションの存在によってユーザープロジェクトを識別します。ワークスペースを起動する際に必要なプロジェクトが存在しない場合、OpenShift Dev Spaces はテンプレート名を使用してプロジェクトを作成します。

OpenShift Dev Spaces の動作は、次の方法で変更できます。

3.2.1. プロジェクト名の設定

OpenShift Dev Spaces がワークスペース起動時に必要なプロジェクトを作成するために使用するプロジェクト名テンプレートを設定できます。

有効なプロジェクト名テンプレートは、次の規則に従います。

-

<username>または<userid>プレースホルダーは必須です。 -

ユーザー名と ID に無効な文字を含めることはできません。ユーザー名または ID のフォーマットが OpenShift オブジェクトの命名規則と互換性がない場合、OpenShift Dev Spaces は、互換性のない文字を

-記号に置き換えてユーザー名や ID を有効な名前に変更します。 -

OpenShift Dev Spaces は、

<userid>プレースホルダーを 14 文字の文字列と判断し、ID が衝突しないようにランダムな 6 文字の接尾辞を追加します。結果は、再利用のためにユーザー設定に保存されます。 - Kubernetes は、プロジェクト名の長さを 63 文字に制限しています。

- OpenShift は、長さをさらに 49 文字に制限しています。

手順

CheClusterカスタムリソースを設定します。「CLI を使用して CheCluster カスタムリソースの設定」 を参照してください。spec: components: devEnvironments: defaultNamespace: template: <workspace_namespace_template_>例3.3 ユーザーワークスペースプロジェクト名テンプレートの例

ユーザーワークスペースプロジェクト名テンプレート 結果のプロジェクト例 <username>-devspaces(デフォルト)user1-devspaces

<userid>-namespacecge1egvsb2nhba-namespace-ul1411<userid>-aka-<username>-namespacecgezegvsb2nhba-aka-user1-namespace-6m2w2b

3.2.2. プロジェクトの事前プロビジョニング

自動プロビジョニングに依存するのではなく、ワークスペースプロジェクトを事前にプロビジョニングできます。ユーザーごとに手順を繰り返します。

手順

次のラベルとアノテーションを使用して、<username> ユーザーの <project_name> プロジェクトを作成します。

kind: Namespace apiVersion: v1 metadata: name: <project_name> 1 labels: app.kubernetes.io/part-of: che.eclipse.org app.kubernetes.io/component: workspaces-namespace annotations: che.eclipse.org/username: <username>

- 1

- 選択したプロジェクト名を使用します。

3.3. サーバーコンポーネントの設定

3.3.1. シークレットまたは ConfigMap をファイルまたは環境変数としての Red Hat OpenShift Dev Spaces コンテナーへのマウント

シークレットは、以下のような機密データを格納する OpenShift オブジェクトです。

- ユーザー名

- パスワード

- 認証トークン

(暗号化された形式)。

ユーザーは、機密データまたは OpenShift Dev Spaces で管理されるコンテナーの設定が含まれる ConfigMap を以下のようにマウントできます。

- ファイル

- 環境変数

マウントプロセスでは、標準の OpenShift マウントメカニズムを使用しますが、追加のアノテーションとラベル付けが必要です。

3.3.1.1. シークレットまたは ConfigMap を OpenShift Dev Spaces コンテナーにファイルとしてマウントする

前提条件

- Red Hat OpenShift Dev Spaces の実行中のインスタンス

手順

OpenShift Dev Spaces がデプロイされている OpenShift プロジェクトに新しい OpenShift シークレットまたは ConfigMap を作成します。作成される予定のオブジェクトのラベルは、ラベルのセットと一致する必要があります。

-

app.kubernetes.io/part-of: che.eclipse.org -

app.kubernetes.io/component: <DEPLOYMENT_NAME>-<OBJECT_KIND> <DEPLOYMENT_NAME>には、以下のデプロイメントのいずれかを使用します。-

devspaces-dashboard -

devfile-registry -

plugin-registry devspacesおよび

-

<jasper_KIND>は以下のいずれかになります。secretまたは、以下を実行します。

-

configmap

-

例3.4 以下に例を示します。

apiVersion: v1

kind: Secret

metadata:

name: custom-settings

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-secret

...または、以下を実行します。

apiVersion: v1

kind: ConfigMap

metadata:

name: custom-settings

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-configmap

...アノテーションの値を設定します。アノテーションは、指定されたオブジェクトがファイルとしてマウントされていることを示す必要があります。

-

che.eclipse.org/mount-as: file- オブジェクトをファイルとしてマウントするように指定します。 -

che.eclipse.org/mount-path: <TARGET_PATH>- 必要なマウントパスを指定します。

-

例3.5 以下に例を示します。

apiVersion: v1

kind: Secret

metadata:

name: custom-data

annotations:

che.eclipse.org/mount-as: file

che.eclipse.org/mount-path: /data

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-secret

...または、以下を実行します。

apiVersion: v1

kind: ConfigMap

metadata:

name: custom-data

annotations:

che.eclipse.org/mount-as: file

che.eclipse.org/mount-path: /data

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-configmap

...OpenShift オブジェクトには複数の項目が含まれる可能性があり、その名前はコンテナーにマウントされる必要なファイル名と一致する必要があります。

例3.6 以下に例を示します。

apiVersion: v1

kind: Secret

metadata:

name: custom-data

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-secret

annotations:

che.eclipse.org/mount-as: file

che.eclipse.org/mount-path: /data

data:

ca.crt: <base64 encoded data content here>または、以下を実行します。

apiVersion: v1

kind: ConfigMap

metadata:

name: custom-data

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-configmap

annotations:

che.eclipse.org/mount-as: file

che.eclipse.org/mount-path: /data

data:

ca.crt: <data content here>

これにより、ca.crt という名前のファイルが OpenShift Dev Spaces コンテナーの /data パスにマウントされます。

OpenShift Dev Spaces コンテナーでの変更を表示するには、シークレットまたは ConfigMap オブジェクト全体を再作成します。

3.3.1.2. シークレットまたは ConfigMap を subPath として OpenShift Dev Spaces コンテナーにマウントする

前提条件

- Red Hat OpenShift Dev Spaces の実行中のインスタンス

手順

OpenShift Dev Spaces がデプロイされている OpenShift プロジェクトに新しい OpenShift シークレットまたは ConfigMap を作成します。作成される予定のオブジェクトのラベルは、ラベルのセットと一致する必要があります。

-

app.kubernetes.io/part-of: che.eclipse.org -

app.kubernetes.io/component: <DEPLOYMENT_NAME>-<OBJECT_KIND> <DEPLOYMENT_NAME>には、以下のデプロイメントのいずれかを使用します。-

devspaces-dashboard -

devfile-registry -

plugin-registry devspacesおよび

-

<jasper_KIND>は以下のいずれかになります。secretまたは、以下を実行します。

-

configmap

-

例3.7 以下に例を示します。

apiVersion: v1

kind: Secret

metadata:

name: custom-settings

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-secret

...または、以下を実行します。

apiVersion: v1

kind: ConfigMap

metadata:

name: custom-settings

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-configmap

...アノテーションの値を設定します。アノテーションは、指定されたオブジェクトが subPath としてマウントされていることを示す必要があります。

-

che.eclipse.org/mount-as: subpath- オブジェクトが subPath としてマウントされていることを示します。 -

che.eclipse.org/mount-path: <TARGET_PATH>- 必要なマウントパスを指定します。

-

例3.8 以下に例を示します。

apiVersion: v1

kind: Secret

metadata:

name: custom-data

annotations:

che.eclipse.org/mount-as: subpath

che.eclipse.org/mount-path: /data

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-secret

...または、以下を実行します。

apiVersion: v1

kind: ConfigMap

metadata:

name: custom-data

annotations:

che.eclipse.org/mount-as: subpath

che.eclipse.org/mount-path: /data

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-configmap

...OpenShift オブジェクトには、コンテナーにマウントされたファイル名と名前が一致する必要がある複数の項目を含めることができます。

例3.9 以下に例を示します。

apiVersion: v1

kind: Secret

metadata:

name: custom-data

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-secret

annotations:

che.eclipse.org/mount-as: subpath

che.eclipse.org/mount-path: /data

data:

ca.crt: <base64 encoded data content here>または、以下を実行します。

apiVersion: v1

kind: ConfigMap

metadata:

name: custom-data

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-configmap

annotations:

che.eclipse.org/mount-as: subpath

che.eclipse.org/mount-path: /data

data:

ca.crt: <data content here>

これにより、ca.crt という名前のファイルが OpenShift Dev Spaces コンテナーの /data パスにマウントされます。

OpenShift Dev Spaces コンテナーでの変更を表示するには、シークレットまたは ConfigMap オブジェクト全体を再作成します。

3.3.1.3. シークレットまたは ConfigMap を環境変数として OpenShift Dev Spaces コンテナーにマウントする

前提条件

- Red Hat OpenShift Dev Spaces の実行中のインスタンス

手順

OpenShift Dev Spaces がデプロイされている OpenShift プロジェクトに新しい OpenShift シークレットまたは ConfigMap を作成します。作成される予定のオブジェクトのラベルは、ラベルのセットと一致する必要があります。

-

app.kubernetes.io/part-of: che.eclipse.org -

app.kubernetes.io/component: <DEPLOYMENT_NAME>-<OBJECT_KIND> <DEPLOYMENT_NAME>には、以下のデプロイメントのいずれかを使用します。-

devspaces-dashboard -

devfile-registry -

plugin-registry devspacesおよび

-

<jasper_KIND>は以下のいずれかになります。secretまたは、以下を実行します。

-

configmap

-

例3.10 以下に例を示します。

apiVersion: v1

kind: Secret

metadata:

name: custom-settings

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-secret

...または、以下を実行します。

apiVersion: v1

kind: ConfigMap

metadata:

name: custom-settings

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-configmap

...アノテーションの値を設定します。アノテーションは、指定されたオブジェクトが環境変数としてマウントされていることを示す必要があります。

-

che.eclipse.org/mount-as: env-: オブジェクトを環境変数としてマウントするように指定します。 -

che.eclipse.org/env-name: <FOOO_ENV>: オブジェクトキー値のマウントに必要な環境変数名を指定します。

-

例3.11 以下に例を示します。

apiVersion: v1

kind: Secret

metadata:

name: custom-settings

annotations:

che.eclipse.org/env-name: FOO_ENV

che.eclipse.org/mount-as: env

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-secret

data:

mykey: myvalueまたは、以下を実行します。

apiVersion: v1

kind: ConfigMap

metadata:

name: custom-settings

annotations:

che.eclipse.org/env-name: FOO_ENV

che.eclipse.org/mount-as: env

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-configmap

data:

mykey: myvalueこれにより、2 つの環境変数が

-

FOO_ENV -

myvalue

OpenShift Dev Spaces コンテナーにプロビジョニングされている。

オブジェクトに複数のデータ項目がある場合、環境変数の名前は以下のようにそれぞれのデータキーについて指定される必要があります。

例3.12 以下に例を示します。

apiVersion: v1

kind: Secret

metadata:

name: custom-settings

annotations:

che.eclipse.org/mount-as: env

che.eclipse.org/mykey_env-name: FOO_ENV

che.eclipse.org/otherkey_env-name: OTHER_ENV

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-secret

stringData:

mykey: <data_content_here>

otherkey: <data_content_here>または、以下を実行します。

apiVersion: v1

kind: ConfigMap

metadata:

name: custom-settings

annotations:

che.eclipse.org/mount-as: env

che.eclipse.org/mykey_env-name: FOO_ENV

che.eclipse.org/otherkey_env-name: OTHER_ENV

labels:

app.kubernetes.io/part-of: che.eclipse.org

app.kubernetes.io/component: devspaces-configmap

data:

mykey: <data content here>

otherkey: <data content here>これにより、2 つの環境変数が

-

FOO_ENV -

OTHER_ENV

OpenShift Dev Spaces コンテナーにプロビジョニングされている。

OpenShift シークレットのアノテーション名の最大長さは 63 文字です。ここで、9 文字は、/ で終わる接頭辞用に予約されます。これは、オブジェクトに使用できるキーの最大長さの制限として機能します。

OpenShift Dev Spaces コンテナーでの変更を表示するには、シークレットまたは ConfigMap オブジェクト全体を再作成します。

3.3.2. Dev Spaces サーバーの高度な設定オプション

以下のセクションでは、OpenShift Dev Spaces サーバーコンポーネントの詳細なデプロイメントおよび設定方法を説明します。

3.3.2.1. OpenShift Dev Spaces サーバーの詳細設定について

以下のセクションでは、OpenShift Dev Spaces サーバーコンポーネントの詳細設定方法について説明します。

詳細設定は以下を実行するために必要です。

-

標準の

CheClusterカスタムリソースフィールドから Operator によって自動的に生成されない環境変数を追加します。 -

標準の

CheClusterカスタムリソースフィールドから Operator によって自動的に生成されるプロパティーを上書きします。

CheCluster Custom Resource server 設定の一部である customCheProperties フィールドには、OpenShift Dev Spaces サーバーコンポーネントに適用する追加の環境変数のマップが含まれます。

例3.13 ワークスペースのデフォルトのメモリー制限の上書き

CheClusterカスタムリソースを設定します。「CLI を使用して CheCluster カスタムリソースの設定」 を参照してください。apiVersion: org.eclipse.che/v2 kind: CheCluster spec: components: cheServer: extraProperties: CHE_LOGS_APPENDERS_IMPL: json

OpenShift Dev Spaces Operator の以前のバージョンには、このロールを果たすために custom という名前の ConfigMap がありました。OpenShift Dev Spaces オペレーターが custom という名前の configMap を見つけると、それに含まれるデータを customCheProperties フィールドに追加し、OpenShift Dev Spaces を再デプロイして、カスタムconfigMap を削除します。

3.3.3. Red Hat OpenShift Dev Spaces コンテナーのレプリカ数の設定

Kubernetes HorizontalPodAutoscaler (HPA) を使用して OpenShift Dev Spaces オペランドのレプリカの数を設定するには、デプロイメント用の HPA リソースを定義します。HPA は 指定されたメトリクスに基づいてレプリカの数を動的に調整します。

手順

ターゲットメトリクスと必要なレプリカ数を指定して、デプロイメント用の

HPAリソースを作成します。apiVersion: autoscaling/v2 kind: HorizontalPodAutoscaler metadata: name: scaler namespace: openshift-devspaces spec: scaleTargetRef: apiVersion: apps/v1 kind: Deployment name: <deployment_name> 1 ...- 1

<deployment_name>は、次のデプロイメントのいずれかに対応します。-

devspaces -

che-gateway -

devspaces-dashboard -

plugin-registry -

devfile-registry

-

例3.14 devspaces デプロイメント用の HorizontalPodAutoscaler を作成します。

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: devspaces-scaler

namespace: openshift-devspaces

spec:

scaleTargetRef:

apiVersion: apps/v1

kind: Deployment

name: devspaces

minReplicas: 2

maxReplicas: 5

metrics:

- type: Resource

resource:

name: cpu

target:

type: Utilization

averageUtilization: 75この例では、HPA は devspaces という名前のデプロイメントをターゲットにしており、レプリカは最小 2 つ、最大 5 つで、CPU 使用率に基づいてスケーリングされます。

3.4. ワークスペースのグローバル設定

このセクションでは、管理者がワークスペースをグローバルに設定する方法について説明します。

3.4.1. ユーザーが保持できるワークスペースの数を制限する

デフォルトでは、ユーザーはダッシュボードに無制限の数のワークスペースを保持できますが、この数を制限してクラスターの需要を減らすことができます。

この設定は、CheCluster カスタムリソースの一部です。

spec:

devEnvironments:

maxNumberOfWorkspacesPerUser: <kept_workspaces_limit>1- 1

- ユーザーごとのワークスペースの最大数を設定します。デフォルト値

-1では、ユーザーは無制限の数のワークスペースを保持できます。ユーザーごとのワークスペースの最大数を設定するには、正の整数を使用します。

手順

OpenShift Dev Spaces namespace の名前を取得します。デフォルトは

openshift-devspacesです。$ oc get checluster --all-namespaces \ -o=jsonpath="{.items[*].metadata.namespace}"maxNumberOfWorkspacesPerUserを設定します。$ oc patch checluster/devspaces -n openshift-devspaces \1 --type='merge' -p \ '{"spec":{"devEnvironments":{"maxNumberOfWorkspacesPerUser": <kept_workspaces_limit>}}}'2

3.4.2. ユーザーが複数のワークスペースを同時に実行できるようにする

デフォルトでは、ユーザーは一度に 1 つのワークスペースしか実行できません。ユーザーが複数のワークスペースを同時に実行できるようにすることができます。

デフォルトのストレージ方法を使用している際、マルチノードクラスター内のノード全体に Pod が分散されている場合は、ワークスペースを同時に実行すると問題が発生する可能性があります。ユーザーごとの common ストレージストラテジーから per-workspace ストレージストラテジーに切り替えるか、ephemeral ストレージタイプを使用すると、これらの問題を回避または解決できます。

この設定は、CheCluster カスタムリソースの一部です。

spec:

devEnvironments:

maxNumberOfRunningWorkspacesPerUser: <running_workspaces_limit>1- 1

- ユーザーごとに同時に実行されるワークスペースの最大数を設定します。値

-1を指定すると、ユーザーはワークスペースを無制限に実行できます。デフォルト値は1です。

手順

OpenShift Dev Spaces namespace の名前を取得します。デフォルトは

openshift-devspacesです。$ oc get checluster --all-namespaces \ -o=jsonpath="{.items[*].metadata.namespace}"maxNumberOfRunningWorkspacesPerUserを設定します。$ oc patch checluster/devspaces -n openshift-devspaces \1 --type='merge' -p \ '{"spec":{"devEnvironments":{"maxNumberOfRunningWorkspacesPerUser": <running_workspaces_limit>}}}'2

3.4.3. 自己署名証明書を使用した Git

自己署名証明書を使用する Git プロバイダーでの操作をサポートするように OpenShift Dev Spaces を設定できます。

前提条件

-

OpenShift クラスターへの管理権限を持つアクティブな

ocセッション。OpenShift CLI の使用開始を 参照してください。 - Git バージョン 2 以降

手順

Git サーバーの詳細情報を使用して新規の configMap を作成します。

$ oc create configmap che-git-self-signed-cert \ --from-file=ca.crt=<path_to_certificate> \ 1 --from-literal=githost=<git_server_url> -n openshift-devspaces 2

- 1

- 自己署名証明書へのパス。

- 2

- Git サーバーの URL を指定するオプションのパラメーター (例:

https://git.example.com:8443)。省略すると、自己署名証明書が HTTPS 経由のすべてのリポジトリーに使用されます。

注記-

証明書ファイルは、通常、以下のような Base64 ASCII ファイルとして保存されます。

.pem,.crt,.ca-bundle.証明書ファイルを保持するすべてのConfigMapはバイナリーデータ証明書ではなく Base64 ASCII 証明書を使用する必要があります。 -

証明書の信頼チェーンが必要です。

ca.crtが認証局 (CA) によって署名されている場合は、CA 証明書がca.crtファイルに含まれている必要があります。

必要なラベルを ConfigMap に追加します。

$ oc label configmap che-git-self-signed-cert \ app.kubernetes.io/part-of=che.eclipse.org -n openshift-devspaces

Git リポジトリーに自己署名証明書を使用するように OpenShift Dev Spaces オペランドを設定します。「CLI を使用して CheCluster カスタムリソースの設定」 を参照してください。

spec: devEnvironments: trustedCerts: gitTrustedCertsConfigMapName: che-git-self-signed-cert

検証手順

新規ワークスペースを作成および開始します。ワークスペースによって使用されるすべてのコンテナーは、自己署名証明書のあるファイルを含む特殊なボリュームをマウントします。コンテナーの

/etc/gitconfigファイルには、Git サーバーホスト (その URL) とhttpセクションの証明書へのパスについての情報が含まれます (git-config に関する Git ドキュメントを参照してください)。例3.15

/etc/gitconfigファイルの内容[http "https://10.33.177.118:3000"] sslCAInfo = /etc/config/che-git-tls-creds/certificate

3.4.4. ワークスペース nodeSelector の設定

このセクションでは、OpenShift Dev Spaces ワークスペースの Pod に nodeSelector を設定する方法を説明します。

手順

NodeSelector の使用

OpenShift Dev Spaces は、

CheClusterカスタムリソースを使用してnodeSelectorを設定します。spec: devEnvironments: nodeSelector: key: valueこのセクションには、nodeSelector ルールを形成するために、各 ノードラベル の

キー = 値のペアのセットが含まれている必要があります。汚染と許容の使用

これは

nodeSelectorとは逆の働きをします。Pod がスケジュールされるノードを指定する代わりに、Pod がスケジュールされないノードを指定します。詳細は、https ://kubernetes.io/docs/concepts/scheduling-eviction/taint-and-toleration を参照してください。OpenShift Dev Spaces は、

CheClusterカスタムリソースを使用して許容範囲を設定します。spec: devEnvironments: tolerations: - effect: NoSchedule key: key value: value operator: Equal

nodeSelector は、OpenShift Dev Spaces のインストール時に設定する必要があります。これにより、既存のワークスペース PVC および Pod が異なるゾーンにスケジュールされることによってボリュームのアフィニティーの競合が生じ、既存のワークスペースが実行できなくなることを防ぐことができます。

大規模なマルチゾーンクラスターの異なるゾーンに Pod および PVC がスケジュールされないようにするには、PVC の作成プロセスを調整する追加の StorageClass オブジェクトを作成します (allowedTopologies フィールドに注目してください)。

CheCluster カスタムリソースを通じて、新しく作成された StorageClass の名前を OpenShift Dev Spaces に渡します。詳細は、以下を参照してください。「ストレージクラスの設定」。

3.4.5. VSX レジストリー URL を開く

エクステンションを検索してインストールするために、Microsoft Visual Studio Code - オープンソースエディターは、組み込みの Open VSX レジストリーインスタンスを使用します。組み込みのレジストリーインスタンスではなく、別の Open VSX レジストリーインスタンスを使用するように OpenShift Dev Spaces を設定することもできます。

手順

CheCluster カスタムリソースの

spec.components.pluginRegistry.openVSXURLフィールドに Open VSX レジストリーインスタンスの URL を設定します。spec: components: # [...] pluginRegistry: openVSXURL: <your_open_vsx_registy> # [...]

3.4.6. ユーザー名前空間の設定

この手順では、OpenShift Dev Spaces を使用して、ConfigMaps、Secrets、および PersistentVolumeClaim をopenshift-devspaces 名前空間から多数のユーザー固有の名前空間に複製するプロセスについて説明します。OpenShift Dev Spaces は、共有認証情報、設定ファイル、証明書などの重要な設定データのユーザー名前空間への同期を自動化します。

openshift-devspaces 名前空間の Kubernetes リソースに変更を加えると、OpenShift Dev Spaces はすべてのユーザー名前空間にわたって変更を直ちに複製します。逆に、Kubernetes リソースがユーザー名前空間で変更された場合、OpenShift Dev Spaces は変更を直ちに元に戻します。

手順

以下の

ConfigMapを作成して、すべてのユーザー名前空間に複製します。設定可能性を高めるために、追加のラベルとアノテーションを追加してConfigMap をカスタマイズできます。その他の可能なラベルとアノテーションについては 、ボリューム、設定マップ、シークレットの自動マウント を参照してください。kind: ConfigMap apiVersion: v1 metadata: name: user-configmap namespace: openshift-devspaces labels: app.kubernetes.io/part-of: che.eclipse.org app.kubernetes.io/component: workspaces-config data: ...例3.16 ユーザーワークスペースに

settings.xmlファイルをマウントします。kind: ConfigMap apiVersion: v1 metadata: name: user-settings-xml namespace: openshift-devspaces labels: app.kubernetes.io/part-of: che.eclipse.org app.kubernetes.io/component: workspaces-config annotations: controller.devfile.io/mount-as: subpath controller.devfile.io/mount-path: /home/user/.m2 data: settings.xml: | <settings xmlns="http://maven.apache.org/SETTINGS/1.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation="http://maven.apache.org/SETTINGS/1.0.0 https://maven.apache.org/xsd/settings-1.0.0.xsd"> <localRepository>/home/user/.m2/repository</localRepository> <interactiveMode>true</interactiveMode> <offline>false</offline> </settings>以下の

Secretを作成して、それをすべてのユーザー名前空間に複製します。設定可能性を高めるために、追加のラベルとアノテーションを追加してSecret をカスタマイズできます。その他の可能なラベルとアノテーションについては 、ボリューム、設定マップ、シークレットの自動マウント を参照してください。kind: Secret apiVersion: v1 metadata: name: user-secret namespace: openshift-devspaces labels: app.kubernetes.io/part-of: che.eclipse.org app.kubernetes.io/component: workspaces-config data: ...例3.17 ユーザーワークスペースに証明書をマウントする:

kind: Secret apiVersion: v1 metadata: name: user-certificates namespace: openshift-devspaces labels: app.kubernetes.io/part-of: che.eclipse.org app.kubernetes.io/component: workspaces-config annotations: controller.devfile.io/mount-as: subpath controller.devfile.io/mount-path: /etc/pki/ca-trust/source/anchors stringData: trusted-certificates.crt: | ...注記ワークスペースの起動時に

update-ca-trustコマンドを実行して証明書をインポートします。これは手動で実行することも、devfile のpostStartイベントにこのコマンドを追加することで実行することもできます。devfile でのイベントバインディングの追加を 参照してください。例3.18 環境変数をユーザーワークスペースにマウントする:

kind: Secret apiVersion: v1 metadata: name: user-env namespace: openshift-devspaces labels: app.kubernetes.io/part-of: che.eclipse.org app.kubernetes.io/component: workspaces-config annotations: controller.devfile.io/mount-as: env stringData: ENV_VAR_1: value_1 ENV_VAR_2: value_2以下の

PersistentVolumeClaimを作成して、それをすべてのユーザー名前空間に複製します。設定可能性を高めるために、追加のラベルとアノテーションを追加して

PersistentVolumeClaimをカスタマイズできます。その他の可能なラベルとアノテーションについては 、ボリューム、設定マップ、シークレットの自動マウント を参照してください。PersistentVolumeClaim を変更するには、これを削除し、openshift-devspaces 名前空間に新しいものを作成します。

apiVersion: v1 kind: PersistentVolumeClaim metadata: name: user-pvc namespace: openshift-devspaces labels: app.kubernetes.io/part-of: che.eclipse.org app.kubernetes.io/component: workspaces-config spec: ...例3.19

PersistentVolumeClaimをユーザーワークスペースにマウントする:apiVersion: v1 kind: PersistentVolumeClaim metadata: name: user-pvc namespace: openshift-devspaces labels: app.kubernetes.io/part-of: che.eclipse.org app.kubernetes.io/component: workspaces-config controller.devfile.io/mount-to-devworkspace: 'true' annotations: controller.devfile.io/mount-path: /home/user/data controller.devfile.io/read-only: 'true' spec: accessModes: - ReadWriteOnce resources: requests: storage: 5Gi volumeMode: Filesystem

関連情報

- https://access.redhat.com/documentation/ja-jp/red_hat_openshift_dev_spaces/3.12/html-single/user_guide/index#end-user-guide:mounting-configmaps

- https://access.redhat.com/documentation/ja-jp/red_hat_openshift_dev_spaces/3.12/html-single/user_guide/index#end-user-guide: マウントシークレット

- https://access.redhat.com/documentation/ja-jp/red_hat_openshift_dev_spaces/3.12/html-single/user_guide/index#end-user-guide:requesting-persistent-storage-for-workspaces

- ボリューム、configmap、シークレットの自動マウント

3.5. ワークスペースの起動を迅速化するイメージのキャッシュ

OpenShift Dev Spaces ワークスペースの起動時間のパフォーマンスを改善するには、Image Puller を使用して OpenShift クラスターのイメージの事前プルに使用できる OpenShift Dev Spaces に依存しないコンポーネントを使用します。Image Puller は、関連する OpenShift Dev Spaces ワークスペースイメージを各ノードで事前にプルするように設定できる DaemonSet を作成する追加の OpenShift デプロイメントです。これらのイメージは、OpenShift Dev Spaces ワークスペースの起動時にすでに利用可能なため、ワークスペースの開始時間が改善されています。

Image Puller は、設定用に以下のパラメーターを提供します。

| パラメーター | 使用方法 | デフォルト |

|---|---|---|

|

| デーモンセットのヘルスチェック間隔 (時間単位) |

|

|

| Puller の実行中にキャッシュされる各イメージのメモリー要求。「メモリー設定の定義」 を参照してください。 |

|

|

| Puller の実行中にキャッシュされる各イメージのメモリー制限。「メモリー設定の定義」 を参照してください。 |

|

|

| Puller の実行中にキャッシュされる各イメージのプロセッサー要求 |

|

|

| Puller の実行中にキャッシュされる各イメージのプロセッサー制限 |

|

|

| 作成するデーモンセットの名前 |

|

|

| 作成するデプロイメントの名前 |

|

|

| 作成するデーモンセットが含まれる OpenShift プロジェクト |

|

|

|

プルするイメージのセミコロンで区切られたリスト ( | |

|

| デーモンセットによって作成される Pod に適用するノードセレクター |

|

|

| DaemonSet によって作成される Pod に適用されるアフィニティー |

|

|

|

DeamonSet で作成される Pod に追加する |

|

関連情報

3.5.1. イメージ一覧の定義

Image Puller は、che-machine-exec などの scratch イメージを含むほとんどのイメージを事前プルできます。ただし、traefik などの Dockerfile にボリュームをマウントするイメージは、OpenShift 3.11 における事前プルではサポートされません。

手順

-

https://<openshift_dev_spaces_fqdn>/plugin-registry/v3/external_images.txtURL に移動して、プルする関連コンテナーイメージのリストを収集します。 -

プル前のリストからイメージを判別します。ワークスペースの起動時間を短縮するには、

universal-developer-image、che-code、che-gatewayなどのワークスペース関連のイメージをプルすることを検討してください。

3.5.2. メモリー設定の定義

メモリー要求および制限パラメーターを定義して、コンテナーをプルし、プラットフォームに実行するのに十分なメモリーがあることを確認します。

前提条件

手順

-

CACHING_MEMORY_REQUESTまたはCACHING_MEMORY_LIMITの最小値を定義するには、プルする各コンテナーイメージの実行に必要なメモリー容量を考慮してください。 CACHING_MEMORY_REQUESTまたはCACHING_MEMORY_LIMITの最大値を定義するには、クラスターのデーモンセット Pod に割り当てられるメモリーの合計を考慮します。(memory limit) * (number of images) * (number of nodes in the cluster)

コンテナーのメモリー制限が

20Miの 20 ノードで 5 つのイメージをプルする場合、2000Miのメモリーが必要です。

3.5.3. Web コンソールを使用した OpenShift への Image Puller のインストール

OpenShift Web コンソールを使用して、コミュニティーでサポートされている Kubernetes Image Puller Operator を OpenShift にインストールできます。

前提条件

- 「イメージ一覧の定義」

- 「メモリー設定の定義」

- クラスター管理者による OpenShift Web コンソールセッション。Web コンソールへのアクセスを 参照してください。

手順

- コミュニティーでサポートされている Kubernetes Image Puller Operator をインストールします。Web コンソールを使用して OperatorHub からインストールするを 参照してください。

-

コミュニティーでサポートされている Kubernetes Image Puller Operator から

KubernetesImagePullerオペランドを作成します。インストールされた Operators からアプリケーションを作成するを 参照してください。

3.5.4. CLI を使用した OpenShift への Image Puller のインストール

OpenShift oc 管理ツールを使用して、OpenShift に Kubernetes Image Puller をインストールできます。

前提条件

- 「イメージ一覧の定義」

- 「メモリー設定の定義」

-

OpenShift クラスターへの管理権限を持つアクティブな

ocセッション。OpenShift CLI の使用開始を 参照してください。

手順

Image Puller リポジトリーのクローンを作成し、OpenShift テンプレートが含まれるディレクトリーを取得します。

$ git clone https://github.com/che-incubator/kubernetes-image-puller $ cd kubernetes-image-puller/deploy/openshift

以下のパラメーターを使用して、

app.yaml、configmap.yamlおよびserviceaccount.yamlOpenShift テンプレートを設定します。表3.38 app.yaml の Image Puller OpenShift テンプレートパラメーター 値 使用方法 デフォルト DEPLOYMENT_NAMEConfigMap の

DEPLOYMENT_NAMEの値kubernetes-image-pullerIMAGEkubernetes-image-pullerデプロイメントに使用されるイメージregistry.redhat.io/devspaces/imagepuller-rhel8IMAGE_TAGプルするイメージタグ

latestSERVICEACCOUNT_NAMEデプロイメントで作成され、使用される ServiceAccount の名前

kubernetes-image-puller表3.39 configmap.yaml の Image Puller OpenShift テンプレートパラメーター 値 使用方法 デフォルト CACHING_CPU_LIMITConfigMap の

CACHING_CPU_LIMITの値.2CACHING_CPU_REQUESTConfigMap の

CACHING_CPU_REQUESTの値.05CACHING_INTERVAL_HOURSConfigMap の

CACHING_INTERVAL_HOURSの値"1"CACHING_MEMORY_LIMITConfigMap の

CACHING_MEMORY_LIMITの値"20Mi"CACHING_MEMORY_REQUESTConfigMap の

CACHING_MEMORY_REQUESTの値"10Mi"DAEMONSET_NAMEConfigMap の

DAEMONSET_NAMEの値kubernetes-image-pullerDEPLOYMENT_NAMEConfigMap の

DEPLOYMENT_NAMEの値kubernetes-image-pullerIMAGESConfigMap の

IMAGESの値"undefined"NAMESPACEConfigMap の

NAMESPACEの値k8s-image-pullerNODE_SELECTORConfigMap の

NODE_SELECTORの値"{}"表3.40 serviceaccount.yaml の Image Puller OpenShift テンプレートパラメーター 値 使用方法 デフォルト SERVICEACCOUNT_NAMEデプロイメントで作成され、使用される ServiceAccount の名前

kubernetes-image-pullerImage Puller をホストする OpenShift プロジェクトを作成します。

$ oc new-project <k8s-image-puller>テンプレートを処理してから適用し、Puller をインストールします。

$ oc process -f serviceaccount.yaml | oc apply -f - $ oc process -f configmap.yaml | oc apply -f - $ oc process -f app.yaml | oc apply -f -

検証手順

<kubernetes-image-puller> デプロイメントおよび <kubernetes-image-puller> デーモンセットがあることを確認します。デーモンセットでは、クラスター内の各ノードに Pod が必要です。

$ oc get deployment,daemonset,pod --namespace <k8s-image-puller><kubernetes-image-puller>

ConfigMapの値を確認します。$ oc get configmap <kubernetes-image-puller> --output yaml

3.6. 可観測性の設定

OpenShift Dev Spaces 可観測性機能を設定するには、以下を参照してください。

3.6.1. Woopra telemetry プラグイン

Woopra Telemetry プラグイン は、Telemetry を Red Hat OpenShift Dev Spaces インストールから Segment および Woopra に送信するためにビルドされたプラグインです。このプラグインは、Red Hat がホストする Eclipse Che で使用されますが、Red Hat OpenShift Dev Spaces デプロイメントではこのプラグインを利用できます。有効な Woopra ドメインおよびセグメント書き込みキー以外の依存関係はありません。プラグインである plugin.yaml の devfile v2 には、プラグインに渡すことのできる 4 つの環境変数があります。

-

WOOPRA_DOMAIN- イベントの送信先となる Woopra ドメイン。 -

SEGMENT_WRITE_KEY- セグメントおよび Woopra にイベントを送信するための書き込みキー。 -

WOOPRA_DOMAIN_ENDPOINT- Woopra ドメインを直接渡さない場合、プラグインは Woopra ドメインを返す指定の HTTP エンドポイントからこれを取得します。 -

SEGMENT_WRITE_KEY_ENDPOINT- セグメント書き込みキーを直接渡さない場合、プラグインはセグメント書き込みキーを返す指定された HTTP エンドポイントからこれを取得します。

Red Hat OpenShift Dev Spaces インストールで Woopra プラグインを有効にするには、以下を実行します。

手順

plugin.yamldevfile v2 ファイルを、環境変数が正しく設定された HTTP サーバーにデプロイします。CheClusterカスタムリソースを設定します。「CLI を使用して CheCluster カスタムリソースの設定」 を参照してください。spec: devEnvironments: defaultPlugins: - editor: eclipse/che-theia/next 1 plugins: 2 - 'https://your-web-server/plugin.yaml'

3.6.2. Telemetry プラグインの作成

本セクションでは、AbstractAnalyticsManager を拡張し、以下のメソッドを実装する AnalyticsManager クラスを作成する方法を説明します。

-

isEnabled(): Telemetry バックエンドが正しく機能しているかどうかを判断します。これは、常にtrueを返すか、接続プロパティーがない場合にfalseを返すなど、より複雑なチェックがあることを意味します。 -

destroy(): Telemetry バックエンドをシャットダウンする前に実行されるクリーンアップ方法。このメソッドは、WORKSPACE_STOPPEDイベントを送信します。 -

onActivity()- 特定のユーザーについて一部のアクティビティーが依然として実行されていることを通知します。これは主にWORKSPACE_INACTIVEイベントを送信するために使用されます。 -

onEvent()- Telemetry イベントをWORKSPACE_USEDまたはWORKSPACE_STARTEDなどの Telemetry サーバーに送信します。 -

increaseDuration()- 短時間に多くのイベントを送信するのではなく、現在のイベントの期間を長くします。

次のセクションでは、以下について説明します。

- Telemetry サーバーを作成してイベントを標準出力にエコーします。

- OpenShift Dev Spaces Telemetry クライアントを拡張して、ユーザーのカスタムバックエンドを実装します。

-

カスタムバックエンドの Dev Workspace プラグインを表す

plugin.yamlファイルを作成します。 -

CheClusterカスタムリソースからworkspacesDefaultPlugins属性を設定して、カスタムプラグインの場所を OpenShift Dev Spaces に指定します。

3.6.2.1. スタートガイド

以下では、OpenShift Dev Spaces Telemetry システムを拡張してカスタムバックエンドと通信するために必要な手順を説明します。

- イベントを受信するサーバープロセスの作成

- イベントをサーバーに送信するバックエンドを作成する OpenShift Dev Spaces ライブラリーの拡張

- コンテナーでの Telemetry バックエンドのパッケージ化およびイメージレジストリーへのデプロイ

- バックエンドのプラグインを追加し、OpenShift Dev Space に Dev Workspaces にプラグインを読み込むよう指示

Telemetry バックエンドの最終的な例については、here を参照してください。

イベントを受信するサーバーの作成

この例は、Telemetry プラグインからイベントを受信し、標準出力に書き込むサーバーを作成する方法を示しています。

実稼働環境のユースケースでは、独自の Telemetry サーバーを作成するのではなく、サードパーティーの Telemetry システム (Segment、Woopra など) との統合を検討してください。この場合、プロバイダーの API を使用してイベントをカスタムバックエンドからシステムに送信します。

以下の Go コードは、ポート 8080 でサーバーを起動し、イベントを標準出力に書き込みます。

例3.20 main.go

package main

import (

"io/ioutil"

"net/http"

"go.uber.org/zap"

)

var logger *zap.SugaredLogger

func event(w http.ResponseWriter, req *http.Request) {

switch req.Method {

case "GET":

logger.Info("GET /event")

case "POST":

logger.Info("POST /event")

}

body, err := req.GetBody()

if err != nil {

logger.With("err", err).Info("error getting body")

return

}

responseBody, err := ioutil.ReadAll(body)

if err != nil {

logger.With("error", err).Info("error reading response body")

return

}

logger.With("body", string(responseBody)).Info("got event")

}

func activity(w http.ResponseWriter, req *http.Request) {

switch req.Method {

case "GET":

logger.Info("GET /activity, doing nothing")

case "POST":

logger.Info("POST /activity")

body, err := req.GetBody()

if err != nil {

logger.With("error", err).Info("error getting body")

return

}

responseBody, err := ioutil.ReadAll(body)

if err != nil {

logger.With("error", err).Info("error reading response body")

return

}

logger.With("body", string(responseBody)).Info("got activity")

}

}

func main() {

log, _ := zap.NewProduction()

logger = log.Sugar()

http.HandleFunc("/event", event)

http.HandleFunc("/activity", activity)

logger.Info("Added Handlers")

logger.Info("Starting to serve")

http.ListenAndServe(":8080", nil)

}

このコードに基づいてコンテナーイメージを作成し、これを OpenShift の openshift-devspaces プロジェクトでデプロイメントとして公開します。サンプル Telemetry サーバーのコードは Telemetry-server-example で利用できます。Telemetry サーバーをデプロイするには、リポジトリーのクローンを作成し、コンテナーをビルドします。

$ git clone https://github.com/che-incubator/telemetry-server-example $ cd telemetry-server-example $ podman build -t registry/organization/telemetry-server-example:latest . $ podman push registry/organization/telemetry-server-example:latest

manifest_with_ingress.yaml および manifest_with_route の両方には、Deployment およびサービスの定義が含まれます。また、前者は Kubernetes Ingress も定義しますが、後者は OpenShift Route を定義します。

マニフェストファイルで、プッシュした image に一致する image および host フィールドと、OpenShift クラスターのパブリックホスト名を置き換えます。次に、以下を実行します。

$ kubectl apply -f manifest_with_[ingress|route].yaml -n openshift-devspaces

3.6.2.2. バックエンドプロジェクトの作成

開発時に迅速なフィードバックを得るには、Dev Workspace 内で開発を行うことが推奨されます。これにより、クラスターでアプリケーションを実行し、フロントエンドの Telemetry プラグインからイベントを受信できます。

Maven Quarkus プロジェクトのスキャフォールディング:

mvn io.quarkus:quarkus-maven-plugin:2.7.1.Final:create \ -DprojectGroupId=mygroup -DprojectArtifactId=devworkspace-telemetry-example-plugin \ -DprojectVersion=1.0.0-SNAPSHOT-

src/main/java/mygroupとsrc/test/java/mygroupの下にあるファイルを削除します。 -

backend-baseの最新バージョンおよび Maven コーディネートについては、GitHub パッケージ を参照してください。 以下の依存関係を

pom.xmlに追加します。例3.21

pom.xml<!-- Required --> <dependency> <groupId>org.eclipse.che.incubator.workspace-telemetry</groupId> <artifactId>backend-base</artifactId> <version>LATEST VERSION FROM PREVIOUS STEP</version> </dependency> <!-- Used to make http requests to the telemetry server --> <dependency> <groupId>io.quarkus</groupId> <artifactId>quarkus-rest-client</artifactId> </dependency> <dependency> <groupId>io.quarkus</groupId> <artifactId>quarkus-rest-client-jackson</artifactId> </dependency>-

read:packagesパーミッションでパーソナルアクセストークンを作成し、GitHub パッケージ からorg.eclipse.che.incubator.workspace-telemetry:backend-base依存関係をダウンロードします。 GitHub ユーザー名、パーソナルアクセストークン、

che-incubatorリポジトリーの詳細を~/.m2/settings.xmlファイルに追加します。例3.22

settings.xml<settings xmlns="http://maven.apache.org/SETTINGS/1.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation="http://maven.apache.org/SETTINGS/1.0.0 http://maven.apache.org/xsd/settings-1.0.0.xsd"> <servers> <server> <id>che-incubator</id> <username>YOUR GITHUB USERNAME</username> <password>YOUR GITHUB TOKEN</password> </server> </servers> <profiles> <profile> <id>github</id> <activation> <activeByDefault>true</activeByDefault> </activation> <repositories> <repository> <id>central</id> <url>https://repo1.maven.org/maven2</url> <releases><enabled>true</enabled></releases> <snapshots><enabled>false</enabled></snapshots> </repository> <repository> <id>che-incubator</id> <url>https://maven.pkg.github.com/che-incubator/che-workspace-telemetry-client</url> </repository> </repositories> </profile> </profiles> </settings>

3.6.2.3. AnalyticsManager の具体的な実装の作成および特殊なロジックの追加

src/main/java/mygroup の下に、プロジェクトに 2 つのファイルを作成します。

-

MainConfiguration.java-AnalyticsManagerに提供される設定が含まれます。 -

AnalyticsManager.java: Telemetry システム固有のロジックが含まれます。

例3.23 MainConfiguration.java

package org.my.group;

import java.util.Optional;

import javax.enterprise.context.Dependent;

import javax.enterprise.inject.Alternative;

import org.eclipse.che.incubator.workspace.telemetry.base.BaseConfiguration;

import org.eclipse.microprofile.config.inject.ConfigProperty;

@Dependent

@Alternative

public class MainConfiguration extends BaseConfiguration {

@ConfigProperty(name = "welcome.message") 1

Optional<String> welcomeMessage; 2

}- 1

- MicroProfile 設定アノテーションは、

welcome.message設定を注入するために使用されます。

バックエンドに固有の設定プロパティーを設定する方法の詳細は、Quarkus 設定リファレンスガイド を参照してください。

例3.24 AnalyticsManager.java

package org.my.group;

import java.util.HashMap;

import java.util.Map;

import javax.enterprise.context.Dependent;

import javax.enterprise.inject.Alternative;

import javax.inject.Inject;

import org.eclipse.che.incubator.workspace.telemetry.base.AbstractAnalyticsManager;

import org.eclipse.che.incubator.workspace.telemetry.base.AnalyticsEvent;

import org.eclipse.che.incubator.workspace.telemetry.finder.DevWorkspaceFinder;

import org.eclipse.che.incubator.workspace.telemetry.finder.UsernameFinder;

import org.eclipse.microprofile.rest.client.inject.RestClient;

import org.slf4j.Logger;

import static org.slf4j.LoggerFactory.getLogger;

@Dependent

@Alternative

public class AnalyticsManager extends AbstractAnalyticsManager {

private static final Logger LOG = getLogger(AbstractAnalyticsManager.class);

public AnalyticsManager(MainConfiguration mainConfiguration, DevWorkspaceFinder devworkspaceFinder, UsernameFinder usernameFinder) {

super(mainConfiguration, devworkspaceFinder, usernameFinder);

mainConfiguration.welcomeMessage.ifPresentOrElse( 1

(str) -> LOG.info("The welcome message is: {}", str),

() -> LOG.info("No welcome message provided")

);

}

@Override

public boolean isEnabled() {

return true;

}

@Override

public void destroy() {}

@Override

public void onEvent(AnalyticsEvent event, String ownerId, String ip, String userAgent, String resolution, Map<String, Object> properties) {

LOG.info("The received event is: {}", event); 2

}

@Override

public void increaseDuration(AnalyticsEvent event, Map<String, Object> properties) { }

@Override

public void onActivity() {}

}

org.my.group.AnalyticsManager と org.my.group.MainConfiguration は代替の Bean であるため、src/main/resources/application.properties の quarkus.arc.selected-alternatives プロパティーを使用して指定します。

例3.25 application.properties

quarkus.arc.selected-alternatives=MainConfiguration,AnalyticsManager

3.6.2.4. Dev Workspace 内でのアプリケーションの実行

Dev Workspace に

DEVWORKSPACE_TELEMETRY_BACKEND_PORT環境変数を設定します。ここで、値は4167に設定されます。spec: template: attributes: workspaceEnv: - name: DEVWORKSPACE_TELEMETRY_BACKEND_PORT value: '4167'- Red Hat OpenShift Dev Spaces ダッシュボードから Dev Workspace を再起動します。

Dev Workspace のターミナルウィンドウ内で以下のコマンドを実行し、アプリケーションを起動します。

--settingsフラグを使用して、GitHub アクセストークンが含まれるsettings.xmlファイルの場所へのパスを指定します。$ mvn --settings=settings.xml quarkus:dev -Dquarkus.http.port=${DEVWORKSPACE_TELEMETRY_BACKEND_PORT}アプリケーションは、フロントエンドプラグインからポート

4167を使用して Telemetry イベントを受け取るようになりました。

検証手順

以下の出力がログに記録されていることを確認します。

INFO [org.ecl.che.inc.AnalyticsManager] (Quarkus Main Thread) No welcome message provided INFO [io.quarkus] (Quarkus Main Thread) devworkspace-telemetry-example-plugin 1.0.0-SNAPSHOT on JVM (powered by Quarkus 2.7.2.Final) started in 0.323s. Listening on: http://localhost:4167 INFO [io.quarkus] (Quarkus Main Thread) Profile dev activated. Live Coding activated. INFO [io.quarkus] (Quarkus Main Thread) Installed features: [cdi, kubernetes-client, rest-client, rest-client-jackson, resteasy, resteasy-jsonb, smallrye-context-propagation, smallrye-openapi, swagger-ui, vertx]

AnalyticsManagerのonEvent()メソッドがフロントエンドプラグインからイベントを受信することを確認するには、l キーを押して Quarkus ライブコーディングを無効にし、IDE 内のファイルを編集します。以下の出力がログに記録されるはずです。INFO [io.qua.dep.dev.RuntimeUpdatesProcessor] (Aesh InputStream Reader) Live reload disabled INFO [org.ecl.che.inc.AnalyticsManager] (executor-thread-2) The received event is: Edit Workspace File in Che

3.6.2.5. isEnabled() の実装

この例では、このメソッドは呼び出されるたびに true を返します。

例3.26 AnalyticsManager.java

@Override

public boolean isEnabled() {

return true;

}

より複雑なロジックを isEnabled() に設定することができます。たとえば、ホストされている OpenShift Dev Spaces Woopra バックエンド は、バックエンドが有効になっているかどうかを判断する前に、設定プロパティーが存在することを確認します。

3.6.2.6. onEvent() の実装

onEvent() は、バックエンドが受信したイベントを Telemetry システムに送信します。サンプルアプリケーションでは、HTTP POST ペイロードを Telemetry サーバーから /event エンドポイントに送信します。

3.6.2.6.1. サンプル Telemetry サーバーへの POST 要求の送信

以下の例では、Telemetry サーバーアプリケーションは http://little-telemetry-server-che.apps-crc.testing の URL で OpenShift にデプロイされます。ここで、apps-crc.testing は OpenShift クラスターの Ingress ドメイン名です。

TelemetryService.javaを作成して RESTEasy REST Client を設定します。例3.27

TelemetryService.javapackage org.my.group; import java.util.Map; import javax.ws.rs.Consumes; import javax.ws.rs.POST; import javax.ws.rs.Path; import javax.ws.rs.core.MediaType; import javax.ws.rs.core.Response; import org.eclipse.microprofile.rest.client.inject.RegisterRestClient; @RegisterRestClient public interface TelemetryService { @POST @Path("/event") 1 @Consumes(MediaType.APPLICATION_JSON) Response sendEvent(Map<String, Object> payload); }- 1

POSTリクエストを行うエンドポイント。

src/main/resources/application.propertiesファイルでTelemetryServiceのベース URL を指定します。例3.28

application.propertiesorg.my.group.TelemetryService/mp-rest/url=http://little-telemetry-server-che.apps-crc.testing

TelemetryServiceをAnalyticsManagerに挿入し、onEvent()でPOSTリクエストを送信します例3.29

AnalyticsManager.java@Dependent @Alternative public class AnalyticsManager extends AbstractAnalyticsManager { @Inject @RestClient TelemetryService telemetryService; ... @Override public void onEvent(AnalyticsEvent event, String ownerId, String ip, String userAgent, String resolution, Map<String, Object> properties) { Map<String, Object> payload = new HashMap<String, Object>(properties); payload.put("event", event); telemetryService.sendEvent(payload); }これにより、HTTP 要求が Telemetry サーバーに送信され、短期間同じイベントが自動的に遅延します。デフォルトの期間は 1500 ミリ秒です。

3.6.2.7. increaseDuration() の実装

多くの Telemetry システムはイベント期間を認識します。AbstractAnalyticsManager は、同じ期間内で発生する同様のイベントを 1 つのイベントにマージします。increaseDuration() のこの実装は no-op です。この方法では、ユーザーの Telemetry プロバイダーの API を使用してイベントまたはイベントプロパティーを変更し、イベントの延長期間を反映します。

例3.30 AnalyticsManager.java

@Override

public void increaseDuration(AnalyticsEvent event, Map<String, Object> properties) {}3.6.2.8. onActivity() の実装

非アクティブなタイムアウトの制限を設定し、最後のイベント時間がタイムアウトよりも長くなる場合は、onActivity() を使用して WORKSPACE_INACTIVE イベントを送信します。

例3.31 AnalyticsManager.java

public class AnalyticsManager extends AbstractAnalyticsManager {

...

private long inactiveTimeLimit = 60000 * 3;

...

@Override

public void onActivity() {

if (System.currentTimeMillis() - lastEventTime >= inactiveTimeLimit) {

onEvent(WORKSPACE_INACTIVE, lastOwnerId, lastIp, lastUserAgent, lastResolution, commonProperties);

}

}3.6.2.9. destroy() の実装

destroy() が呼び出される際に、WORKSPACE_STOPPED イベントを送信し、接続プールなどのリソースをシャットダウンします。

例3.32 AnalyticsManager.java

@Override

public void destroy() {

onEvent(WORKSPACE_STOPPED, lastOwnerId, lastIp, lastUserAgent, lastResolution, commonProperties);

}

「Dev Workspace 内でのアプリケーションの実行」 で説明されているように mvn quarkus:dev を実行し、Ctrl+C でアプリケーションを終了すると、WORKSPACE_STOPPED イベントがサーバーに送信されます。

3.6.2.10. Quarkus アプリケーションのパッケージ化

アプリケーションをコンテナーにパッケージ化する最適な方法については、Quarkus ドキュメント を参照してください。コンテナーをビルドし、選択したコンテナーレジストリーにプッシュします。

3.6.2.10.1. JVM で実行する Quarkus イメージをビルドするための Dockerfile の例

例3.33 Dockerfile.jvm

FROM registry.access.redhat.com/ubi8/openjdk-11:1.11

ENV LANG='en_US.UTF-8' LANGUAGE='en_US:en'

COPY --chown=185 target/quarkus-app/lib/ /deployments/lib/

COPY --chown=185 target/quarkus-app/*.jar /deployments/

COPY --chown=185 target/quarkus-app/app/ /deployments/app/

COPY --chown=185 target/quarkus-app/quarkus/ /deployments/quarkus/

EXPOSE 8080

USER 185

ENTRYPOINT ["java", "-Dquarkus.http.host=0.0.0.0", "-Djava.util.logging.manager=org.jboss.logmanager.LogManager", "-Dquarkus.http.port=${DEVWORKSPACE_TELEMETRY_BACKEND_PORT}", "-jar", "/deployments/quarkus-run.jar"]イメージをビルドするには、以下を実行します。

mvn package && \ podman build -f src/main/docker/Dockerfile.jvm -t image:tag .

3.6.2.10.2. Quarkus ネイティブイメージをビルドするための Dockerfile の例

例3.34 Dockerfile.native

FROM registry.access.redhat.com/ubi8/ubi-minimal:8.5

WORKDIR /work/

RUN chown 1001 /work \

&& chmod "g+rwX" /work \

&& chown 1001:root /work

COPY --chown=1001:root target/*-runner /work/application

EXPOSE 8080

USER 1001

CMD ["./application", "-Dquarkus.http.host=0.0.0.0", "-Dquarkus.http.port=$DEVWORKSPACE_TELEMETRY_BACKEND_PORT}"]イメージをビルドするには、以下を実行します。

mvn package -Pnative -Dquarkus.native.container-build=true && \ podman build -f src/main/docker/Dockerfile.native -t image:tag .

3.6.2.11. プラグインの plugin.yaml の作成

DevWorkspacePod でカスタムバックエンドを実行する DevWorkspace プラグインを表す plugin.yamldevfilev2 ファイルを作成します。devfile v2 の詳細については、Devfile v2 documentation を参照してください。

例3.35 plugin.yaml

schemaVersion: 2.1.0

metadata:

name: devworkspace-telemetry-backend-plugin

version: 0.0.1

description: A Demo telemetry backend

displayName: Devworkspace Telemetry Backend

components:

- name: devworkspace-telemetry-backend-plugin

attributes:

workspaceEnv:

- name: DEVWORKSPACE_TELEMETRY_BACKEND_PORT

value: '4167'

container:

image: YOUR IMAGE 1

env:

- name: WELCOME_MESSAGE 2

value: 'hello world!'- 1

- 「Quarkus アプリケーションのパッケージ化」 からビルドされたコンテナーイメージを指定します。

- 2

- Example 4 から

welcome.messageオプションの設定プロパティーの値を設定します。

通常、ユーザーはこのファイルを企業 Web サーバーにデプロイします。本書では、OpenShift で Apache Web サーバーを作成し、そこでプラグインをホストする方法を説明します。

新規 plugin.yaml ファイルを参照する ConfigMap オブジェクトを作成します。

$ oc create configmap --from-file=plugin.yaml -n openshift-devspaces telemetry-plugin-yaml

Web サーバーを公開するためにデプロイメント、サービス、およびルートを作成します。デプロイメントはこの ConfigMap オブジェクトを参照し、これを /var/www/html ディレクトリーに配置します。

例3.36 manifest.yaml

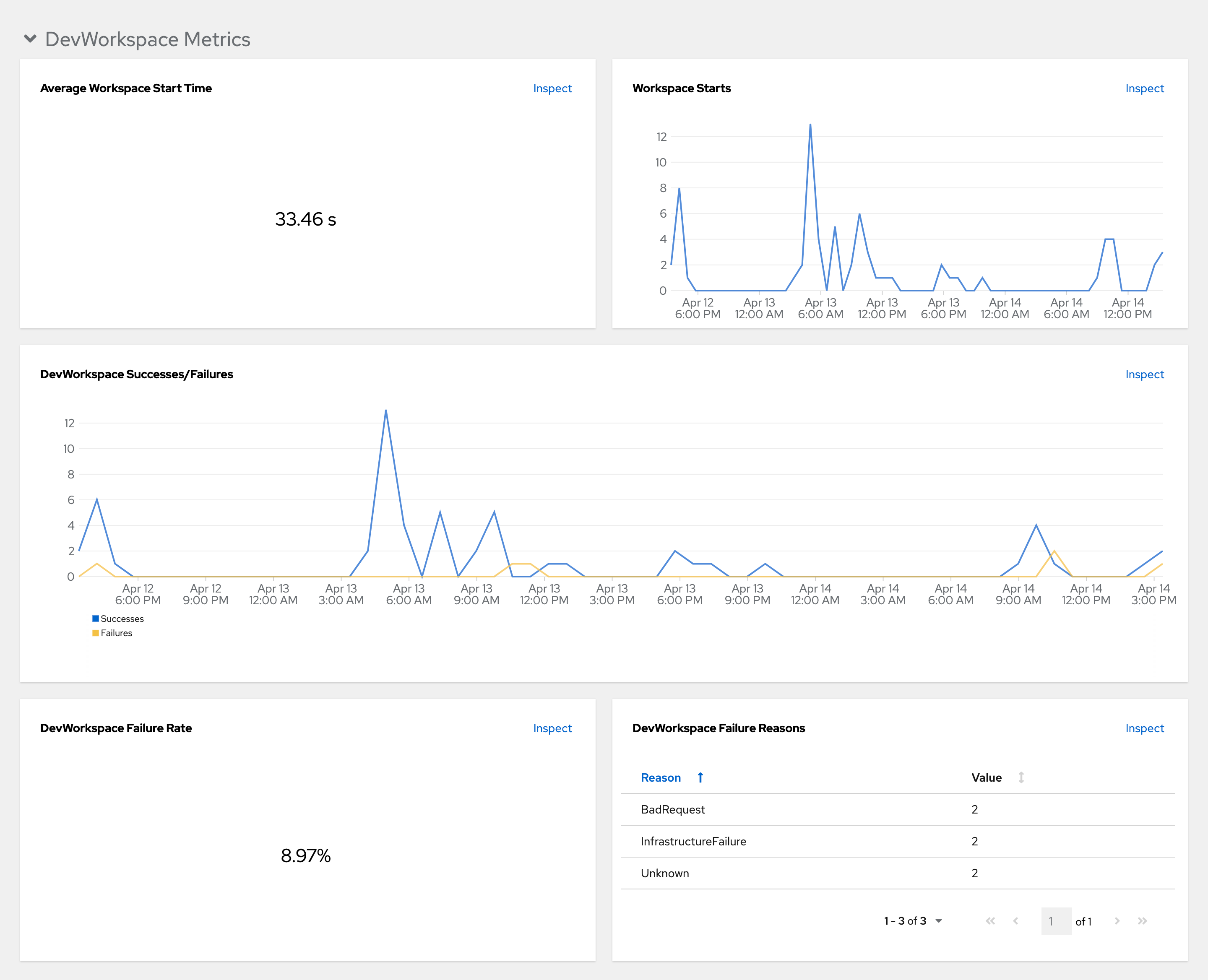

kind: Deployment