Operators

Red Hat OpenShift Service on AWS クラシックアーキテクチャー Operators

概要

第1章 Operator の概要

Operator は、Red Hat OpenShift Service on AWS の最も重要なコンポーネントの 1 つです。これらは、コントロールプレーン上でサービスをパッケージ化、デプロイ、および管理するための推奨される方法です。Operator の使用は、ユーザーが実行するアプリケーションにも各種の利点があります。

Operators は、kubectl や OpenShift CLI (oc) などの Kubernetes API および CLI ツールと統合します。Operator はアプリケーションの監視、ヘルスチェックの実行、OTA (over-the-air) 更新の管理を実行し、アプリケーションが指定した状態にあることを確認するための手段となります。

Operators は、Kubernetes ネイティブアプリケーション向けに特別に設計されており、インストールや設定などの一般的な Day 1 オペレーションを実装および自動化します。Operators は、自動スケールアップや自動スケールダウン、バックアップの作成など、Day 2 オペレーションを自動化することもできます。これらのアクティビティーは、クラスター上で実行されているソフトウェアによってすべて制御されます。

Red Hat OpenShift Service on AWS の Operator は、目的に応じて 2 つの異なるシステムによって管理されます。どちらも同様の Operator の概念と目標に準拠しています。

- クラスター Operator

- Cluster Version Operator (CVO) により管理され、クラスター機能を実行するためにデフォルトでインストールされます。

- オプションのアドオン Operators

- Operator Lifecycle Manager (OLM) により管理され、ユーザーがアプリケーションで実行するようにアクセスを可能にします。OLM ベースの Operators とも呼ばれます。

1.1. 開発者の場合

Operator 作成者は、OLM ベースの Operators に関して、次の開発タスクを実行できます。

1.2. 管理者の場合

dedicated-admin ロールを持つ管理者は、次の Operator タスクを実行できます。

- カスタムカタログを管理 します。

- ソフトウェアカタログから Operator をインストール します。

- オペレータのステータスを表示 します。

- Operator の状態を管理 します。

- インストールされている Operators をアップグレード します。

- インストールされている Operators を削除 します。

- プロキシーサポートを設定 します。

1.3. 次のステップ

第2章 Operators について

2.1. Operators について

概念的に言うと、Operators は人間の運用上のナレッジを使用し、これをコンシューマーと簡単に共有できるソフトウェアにエンコードします。

Operator は、ソフトウェアの他の部分を実行する運用上の複雑さを軽減するソフトウェアの特定の部分で設定されます。Operator はソフトウェアベンダーのエンジニアリングチームの一員のように機能し、Kubernetes 環境 (Red Hat OpenShift Service on AWS など) を監視し、その現在の状態を使用してリアルタイムで意思決定を行います。高度な Operator はアップグレードをシームレスに実行し、障害に自動的に対応するように設計されており、時間の節約のためにソフトウェアのバックアッププロセスを省略するなどのショートカットを実行することはありません。

技術的に言うと、Operators は Kubernetes アプリケーションをパッケージ化し、デプロイし、管理する方法です。

Kubernetes アプリケーションは、Kubernetes にデプロイされ、Kubernetes API および kubectl または oc ツールを使用して管理されるアプリケーションです。Kubernetes を最大限に活用するには、Kubernetes 上で実行されるアプリケーションを提供し、管理するために拡張できるように一連の総合的な API が必要です。Operators は、Kubernetes 上でこのタイプのアプリケーションを管理するランタイムと見なすことができます。

2.1.1. Operators を使用する理由

Operators は以下を提供します。

- インストールおよびアップグレードの反復性。

- すべてのシステムコンポーネントの継続的なヘルスチェック。

- OpenShift コンポーネントおよび ISV コンテンツの OTA (Over-the-air) 更新。

- フィールドエンジニアの知識を凝縮し、1 人や 2 人だけでなくすべてのユーザーに広める場所。

- Kubernetes にデプロイする理由

- Kubernetes (延長線上で考えると Red Hat OpenShift Service on AWS も含まれる) には、シークレットの処理、負荷分散、サービスの検出、自動スケーリングなどの、オンプレミスおよびクラウドプロバイダーで機能する、複雑な分散システムをビルドするために必要なすべてのプリミティブが含まれます。

- アプリケーションを Kubernetes API および

kubectlツールで管理する理由 -

これらの API は機能的に充実しており、すべてのプラットフォームのクライアントを持ち、クラスターのアクセス制御/監査機能にプラグインします。Operator は Kubernetes の拡張メカニズム、カスタムリソース定義 (CRD、Custom Resource Definition ) を使用するため、

MongoDBなど のカスタムオブジェクトは、ビルトインされたネイティブ Kubernetes オブジェクトのように表示され、機能します。 - Operators とサービスブローカーとの比較

- サービスブローカーは、アプリケーションのプログラムによる検出およびデプロイメントを行うための 1 つの手段です。ただし、これは長期的に実行されるプロセスではないため、アップグレード、フェイルオーバー、またはスケーリングなどの Day 2 オペレーションを実行できません。カスタマイズおよびチューニング可能なパラメーターはインストール時に提供されるのに対し、Operator はクラスターの最新の状態を常に監視します。クラスター外のサービスを使用する場合は、Operators もこれらのクラスター外のサービスに使用できますが、これらをサービスブローカーで使用できます。

2.1.2. Operator Framework

Operator Framework は、上記のカスタマーエクスペリエンスに関連して提供されるツールおよび機能のファミリーです。これは、コードを作成するためだけにあるのではなく、Operators のテスト、実行、および更新などの重要な機能を実行します。Operator Framework コンポーネントは、これらの課題に対応するためのオープンソースツールで構成されています。

- Operator Lifecycle Manager

- Operator Lifecycle Manager (OLM) は、クラスター内の Operators のインストール、アップグレード、ロールベースのアクセス制御 (RBAC) を制御します。Red Hat OpenShift Service on AWS ではデフォルトでデプロイされます。

- Operator Registry

- Operator Registry は、クラスターで作成するためのクラスターサービスバージョン (Cluster Service Version、CSV) およびカスタムリソース定義 (CRD) を保存し、パッケージおよびチャネルに関する Operator メタデータを保存します。これは Kubernetes または OpenShift クラスターで実行され、この Operator カタログデータを OLM に指定します。

- ソフトウェアカタログ

- ソフトウェアカタログは、クラスター管理者がクラスターにインストールする Operator を検索して選択するための Web コンソールです。Red Hat OpenShift Service on AWS ではデフォルトでデプロイされます。

これらのツールは組み立て可能なツールとして設計されているため、役に立つと思われるツールを使用できます。

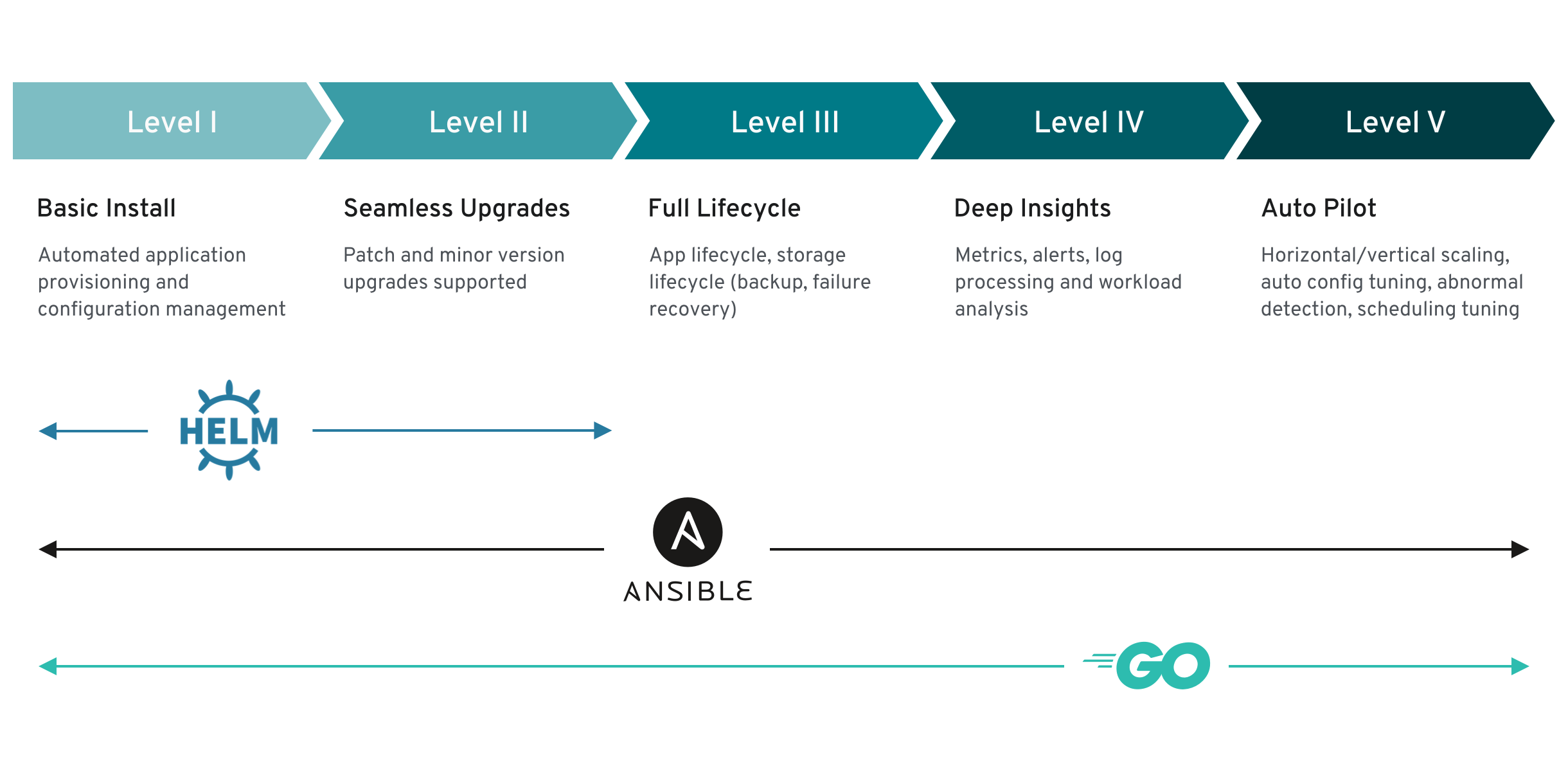

2.1.3. Operator 成熟度モデル

Operator 内にカプセル化されている管理ロジックの複雑さのレベルはさまざまです。また、このロジックは通常 Operator によって表されるサービスのタイプによって大きく変わります。

ただし、大半の Operators に含まれる特定の機能セットは、Operator のカプセル化された操作の成熟度の規模を一般化することができます。このため、以下の Operator 成熟度モデルは、Operator の一般的な Day 2 オペレーションに関する 5 つのフェーズの成熟度を定義しています。

図2.1 Operator 成熟度モデル

2.2. Operator Framework パッケージ形式

ここでは、Red Hat OpenShift Service on AWS の Operator Lifecycle Manager (OLM) によってサポートされる Operator のパッケージ形式の概要を説明します。

2.2.1. Bundle Format

Operators の Bundle Format は、Operator Framework によって導入されるパッケージ形式です。スケーラビリティーを向上させ、アップストリームユーザーがより効果的に独自のカタログをホストできるようにするために、Bundle Format 仕様は Operator メタデータのディストリビューションを単純化します。

Operator バンドルは、Operator の単一バージョンを表します。ディスク上の バンドルマニフェスト は、Kubernetes マニフェストおよび Operator メタデータを保存する実行不可能なコンテナーイメージである バンドルイメージ としてコンテナー化され、提供されます。次に、バンドルイメージの保存および配布は、podman、docker、および Quay などのコンテナーレジストリーを使用して管理されます。

Operator メタデータには以下を含めることができます。

- Operator を識別する情報 (名前およびバージョンなど)。

- UI を駆動する追加情報 (アイコンや一部のカスタムリソース (CR) など)。

- 必須および提供される API。

- 関連するイメージ。

マニフェストを Operator Registry データベースに読み込む際に、以下の要件が検証されます。

- バンドルには、アノテーションで定義された 1 つ以上のチャネルが含まれる必要がある。

- すべてのバンドルには、1 つのクラスターサービスバージョン (CSV) がある。

- CSV がクラスターリソース定義 (CRD) を所有する場合、その CRD はバンドルに存在する必要がある。

2.2.1.1. マニフェスト

バンドルマニフェストは、Operator のデプロイメントおよび RBAC モデルを定義する Kubernetes マニフェストのセットを指します。

バンドルには、ディレクトリーごとに 1 つの CSV が含まれています。通常、その /manifests ディレクトリーには、CSV が所有する API を定義する CRD が格納されています。

Bundle Format のレイアウトの例

2.2.1.1.1. その他のサポート対象のオブジェクト

以下のオブジェクトタイプは、バンドルの /manifests ディレクトリーにオプションとして追加することもできます。

サポート対象のオプションオブジェクトタイプ

-

ClusterRole -

ClusterRoleBinding -

ConfigMap -

ConsoleCLIDownload -

ConsoleLink -

ConsoleQuickStart -

ConsoleYamlSample -

PodDisruptionBudget -

PriorityClass -

PrometheusRule -

Role -

RoleBinding -

Secret -

Service -

ServiceAccount -

ServiceMonitor -

VerticalPodAutoscaler

これらのオプションオブジェクトがバンドルに含まれる場合、Operator Lifecycle Manager (OLM) はバンドルからこれらを作成し、CSV と共にそれらのライフサイクルを管理できます。

オプションオブジェクトのライフサイクル

- CSV が削除されると、OLM はオプションオブジェクトを削除します。

CSV がアップグレードされると、以下を実行します。

- オプションオブジェクトの名前が同じである場合、OLM はこれを更新します。

- オプションオブジェクトの名前がバージョン間で変更された場合、OLM はこれを削除し、再作成します。

2.2.1.2. アノテーション

バンドルには、/metadata ディレクトリーに annotations.yaml ファイルも含まれています。このファイルは、バンドルをバンドルのインデックスに追加する方法に関する形式およびパッケージ情報の記述に役立つ高レベルの集計データを定義します。

annotations.yaml の例

- 1

- Operator バンドルのメディアタイプまたは形式。

registry+v1形式の場合、これに CSV および関連付けられた Kubernetes オブジェクトが含まれることを意味します。 - 2

- Operator マニフェストが含まれるディレクトリーへのイメージのパス。このラベルは今後使用するために予約され、現時点ではデフォの

manifests/に設定されています。manifests.v1の値は、バンドルに Operator マニフェストが含まれることを示します。 - 3

- バンドルに関するメタデータファイルが含まれるディレクトリーへのイメージのパス。このラベルは今後使用するために予約され、現時点ではデフォの

metadata/に設定されています。metadata.v1の値は、このバンドルに Operator メタデータがあることを意味します。 - 4

- バンドルのパッケージ名。

- 5

- Operator Registry に追加される際にバンドルがサブスクライブするチャネルのリスト。

- 6

- レジストリーからインストールされる場合に Operator がサブスクライブされるデフォルトチャネル。

一致しない場合、annotations.yaml ファイルは、これらのアノテーションに依存するクラスター上の Operator Registry のみがこのファイルにアクセスできるために権威を持つファイルになります。

2.2.1.3. Dependencies

Operator の依存関係は、バンドルの metadata/ フォルダー内の dependencies.yaml ファイルに一覧表示されます。このファイルはオプションであり、現時点では明示的な Operator バージョンの依存関係を指定するためにのみ使用されます。

依存関係の一覧には、依存関係の内容を指定するために各項目の type フィールドが含まれます。次のタイプの Operator 依存関係がサポートされています。

olm.package-

このタイプは、特定の Operator バージョンの依存関係であることを意味します。依存関係情報には、パッケージ名とパッケージのバージョンを semver 形式で含める必要があります。たとえば、

0.5.2などの特定バージョンや>0.5.1などのバージョンの範囲を指定することができます。 olm.gvk- このタイプの場合、作成者は CSV の既存の CRD および API ベースの使用方法と同様に group/version/kind (GVK) 情報で依存関係を指定できます。これは、Operator の作成者がすべての依存関係、API または明示的なバージョンを同じ場所に配置できるようにするパスです。

olm.constraint- このタイプは、任意の Operator プロパティーに対するジェネリック制約を宣言します。

以下の例では、依存関係は Prometheus Operator および etcd CRD に指定されます。

dependencies.yaml ファイルの例

2.2.1.4. opm CLI について

opm CLI ツールは、Operator Bundle Format で使用するために Operator Framework によって提供されます。このツールを使用して、ソフトウェアリポジトリーに相当する Operator バンドルのリストから Operators のカタログを作成し、維持することができます。結果として、コンテナーイメージをコンテナーレジストリーに保存し、その後にクラスターにインストールできます。

カタログには、コンテナーイメージの実行時に提供される組み込まれた API を使用してクエリーできる、Operator マニフェストコンテンツへのポインターのデータベースが含まれます。Red Hat OpenShift Service on AWS では、Operator Lifecycle Manager (OLM) は、CatalogSource オブジェクトが定義したカタログソース内のイメージ参照できます。これにより、クラスター上にインストールされた Operator への頻度の高い更新を可能にするためにイメージを一定の間隔でポーリングできます。

-

opmCLI のインストール手順は、CLI ツール を参照してください。

2.2.2. 主な特徴

ファイルベースのカタログ は、Operator Lifecycle Manager (OLM) の最新バージョンのカタログ形式です。この形式は、プレーンテキストベース (JSON または YAML) であり、以前の SQLite データベース形式の宣言的な設定の進化であり、完全な下位互換性があります。この形式の目標は、Operator のカタログ編集、設定可能性、および拡張性を有効にすることです。

- 編集

ファイルベースのカタログを使用すると、カタログの内容を操作するユーザーは、形式を直接変更し、変更が有効であることを確認できます。この形式はプレーンテキストの JSON または YAML であるため、カタログメンテナーは、一般的に知られている、サポート対象の JSON または YAML ツール (例:

jqCLI) を使用して、手動でカタログメタデータを簡単に操作できます。この編集機能により、以下の機能とユーザー定義の拡張が有効になります。

- 既存のバンドルの新規チャネルへのプロモート

- パッケージのデフォルトチャネルの変更

- アップグレードパスを追加、更新、および削除するためのカスタムアルゴリズム

- コンポーザービリティー

ファイルベースのカタログは、任意のディレクトリー階層に保管され、カタログの作成が可能になります。たとえば、2 つのファイルベースのカタログディレクトリー (

catalogAおよびcatalogB) を見てみましょう。カタログメンテナーは、新規のディレクトリーcatalogCを作成してcatalogAとcatalogBをそのディレクトリーにコピーし、新しく結合カタログを作成できます。このコンポーザービリティーにより、カタログの分散化が可能になります。この形式により、Operator の作成者は Operator 固有のカタログを維持でき、メンテナーは個別の Operator カタログで構成されるカタログを簡単にビルドできます。ファイルベースのカタログは、他の複数のカタログを組み合わせたり、1 つのカタログのサブセットを抽出したり、またはこれらの両方を組み合わせたりすることで作成できます。

注記パッケージ内でパッケージおよびバンドルを重複できません。

opm validateコマンドは、重複が見つかった場合はエラーを返します。Operator の作成者は Operator、その依存関係およびそのアップグレードの互換性を最も理解しているので、Operator 固有のカタログを独自のカタログに維持し、そのコンテンツを直接制御できます。ファイルベースのカタログの場合に、Operator の作成者はカタログでパッケージをビルドして維持するタスクを所有します。ただし、複合カタログメンテナーは、カタログ内のパッケージのキュレートおよびユーザーにカタログを公開するタスクのみを所有します。

- 拡張性

ファイルベースのカタログ仕様は、カタログの低レベル表現です。これは低レベルの形式で直接保守できますが、カタログメンテナーは、このレベルの上に任意の拡張をビルドして、独自のカスタムツールを使用して任意数の変更を加えることができます。

たとえば、

(mode=semver)などの高レベルの API を、アップグレードパス用に低レベルのファイルベースのカタログ形式にツールで変換できます。または、カタログメンテナーは、特定の条件を満たすバンドルに新規プロパティーを追加して、すべてのバンドルメタデータをカスタマイズする必要がある場合があります。このような拡張性を使用すると、今後の Red Hat OpenShift Service on AWS リリース向けに、追加の正式なツールを低レベル API 上で開発できます。主な利点としては、カタログメンテナーもこの機能を利用できる点が挙げられます。

Red Hat OpenShift Service on AWS 4.11 の時点で、デフォルトの Red Hat が提供する Operator カタログは、ファイルベースのカタログ形式でリリースされます。Red Hat OpenShift Service on AWS 4.6 から 4.10 までのデフォルトの Red Hat が提供する Operator カタログは、非推奨の SQLite データベース形式でリリースされました。

opm サブコマンド、フラグ、および SQLite データベース形式に関連する機能も非推奨となり、今後のリリースで削除されます。機能は引き続きサポートされており、非推奨の SQLite データベース形式を使用するカタログに使用する必要があります。

opm index prune などの SQLite データベース形式を使用する opm サブコマンドおよびフラグの多くは、ファイルベースのカタログ形式では機能しません。ファイルベースのカタログを使用する方法の詳細は、カスタムカタログの管理 を参照してください。

2.2.2.1. ディレクトリー構造

ファイルベースのカタログは、ディレクトリーベースのファイルシステムから保存してロードできます。opm CLI は、root ディレクトリーを元に、サブディレクトリーに再帰してカタログを読み込みます。CLI は、検出されるすべてのファイルの読み込みを試行し、エラーが発生した場合には失敗します。

.gitignore ファイルとパターンと優先順位が同じ .indexignore ファイルを使用して、カタログ以外のファイルを無視できます。

例: .indexignore ファイル

カタログメンテナーは、必要なレイアウトを柔軟に選択できますが、各パッケージのファイルベースのカタログ Blob は別々のサブディレクトリーに保管することを推奨します。個々のファイルは JSON または YAML のいずれかをしようしてください。カタログ内のすべてのファイルが同じ形式を使用する必要はありません。

推奨される基本構造

この推奨の構造には、ディレクトリー階層内の各サブディレクトリーは自己完結型のカタログであるという特性があるため、カタログの作成、検出、およびナビゲーションなどのファイルシステムの操作が簡素化されます。このカタログは、親カタログのルートディレクトリーにコピーして親カタログに追加することもできます。

2.2.2.2. スキーマ

ファイルベースのカタログは、任意のスキーマで拡張できる CUE 言語仕様 に基づく形式を使用します。以下の _Meta CUE スキーマは、すべてのファイルベースのカタログ Blob が順守する必要のある形式を定義します。

_Meta スキーマ

この仕様にリストされている CUE スキーマは網羅されていると見なされます。opm validate コマンドには、CUE で簡潔に記述するのが困難または不可能な追加の検証が含まれます。

Operator Lifecycle Manager(OLM) カタログは、現時点で OLM の既存のパッケージおよびバンドルの概念に対応する 3 つのスキーマ (olm.package、olm.channel および olm.bundle) を使用します。

カタログの各 Operator パッケージには、olm.package Blob が 1 つ (少なくとも olm.channel Blob 1 つ、および 1 つ以上の olm.bundle Blob) が必要です。

olm.* スキーマは OLM 定義スキーマ用に予約されています。カスタムスキーマには、所有しているドメインなど、一意の接頭辞を使用する必要があります。

2.2.2.2.1. olm.package スキーマ

olm.package スキーマは Operator のパッケージレベルのメタデータを定義します。これには、名前、説明、デフォルトのチャネル、およびアイコンが含まれます。

例2.1 olm.package スキーマ

2.2.2.2.2. olm.channel スキーマ

olm.channel スキーマは、パッケージ内のチャネル、チャネルのメンバーであるバンドルエントリー、およびそのバンドルのアップグレードパスを定義します。

バンドルエントリーが複数の olm.channel Blob 内のエッジを表す場合、バンドルエントリーはチャネルごとに 1 つだけ指定できます。

エントリーの replaces 値が、このカタログにも別のカタログにも存在しない別のバンドル名を参照していても、有効とされます。ただし、他のすべてのチャネルの普遍条件に該当する必要があります (チャネルに複数のヘッドがない場合など)。

例2.2 olm.channel スキーマ

skipRange フィールドを使用すると、スキップされた Operator バージョンが更新グラフからプルーニングされ、ユーザーが Subscription オブジェクトの spec.startingCSV プロパティーを使用してそのバージョンをインストールできなくなります。

skipRange フィールドと replaces フィールドの両方を使用すると、以前にインストールしたバージョンをユーザーが将来インストールできるように維持しながら、Operator を段階的に更新できます。replaces フィールドが当該 Operator バージョンの直前のバージョンを参照していることを確認してください。

2.2.2.2.3. olm.bundle スキーマ

例2.3 olm.bundle スキーマ

2.2.2.2.4. olm.deprecations スキーマ

オプションの olm.deprecations スキーマは、カタログ内のパッケージ、バンドル、チャネルの非推奨情報を定義します。Operator の作成者は、このスキーマを使用して、サポートステータスや推奨アップグレードパスなど、Operators に関する関連メッセージを、カタログから Operators を実行しているユーザーに提供できます。

このスキーマが定義されている場合、Red Hat OpenShift Service on AWS の Web コンソールで、ソフトウェアカタログのインストール前ページとインストール後ページの両方に、カスタムの非推奨メッセージを含め、Operator の影響を受ける要素に対する警告バッジが表示されます。

olm.deprecations スキーマエントリーには、非推奨の範囲を示す次の reference タイプが 1 つ以上含まれています。Operator がインストールされると、指定されたメッセージが、関連する Subscription オブジェクトのステータス状況として表示されます。

| 型 | スコープ | ステータス状況 |

|---|---|---|

|

| パッケージ全体を表します。 |

|

|

| 1 つのチャンネルを表します。 |

|

|

| 1 つのバンドルバージョンを表します。 |

|

次の例で詳しく説明するように、各 reference タイプには独自の要件があります。

例2.4 各 reference タイプを使用した olm.deprecations スキーマの例

- 1

- 各非推奨スキーマには

package値が必要であり、そのパッケージ参照はカタログ全体で一意である必要があります。関連するnameフィールドを含めることはできません。 - 2

olm.packageスキーマにnameフィールドを含めることはできません。このフィールドは、スキーマ内で前に定義したpackageフィールドによって決定されるためです。- 3

- すべての

messageフィールドは、referenceタイプを問わず、長さが 0 以外である必要があり、不透明なテキスト Blob として表す必要があります。 - 4

olm.channelスキーマのnameフィールドは必須です。- 5

olm.bundleスキーマのnameフィールドは必須です。

非推奨機能では、パッケージ、チャネル、バンドルなど、重複する非推奨は考慮されません。

Operator の作成者は、olm.deprecations スキーマエントリーを deprecations.yaml ファイルとしてパッケージの index.yaml ファイルと同じディレクトリーに保存できます。

非推奨を含むカタログのディレクトリー構造の例

my-catalog

└── my-operator

├── index.yaml

└── deprecations.yaml

my-catalog

└── my-operator

├── index.yaml

└── deprecations.yaml2.2.2.3. プロパティー

プロパティーは、ファイルベースのカタログスキーマに追加できる任意のメタデータです。type フィールドは、value フィールドのセマンティックおよび構文上の意味を効果的に指定する文字列です。値には任意の JSON または YAML を使用できます。

OLM は、予約済みの olm.* 接頭辞をもう一度使用して、いくつかのプロパティータイプを定義します。

2.2.2.3.1. olm.package プロパティー

olm.package プロパティーは、パッケージ名とバージョンを定義します。これはバンドルの必須プロパティーであり、これらのプロパティーが 1 つ必要です。packageName フィールドはバンドルのファーストクラス package フィールドと同じでなければならず、version フィールドは有効なセマンティクスバージョンである必要があります。

例2.5 olm.package プロパティー

2.2.2.3.2. olm.gvk プロパティー

olm.gvk プロパティーは、このバンドルで提供される Kubernetes API の group/version/kind(GVK) を定義します。このプロパティーは、OLM が使用して、必須の API と同じ GVK をリストする他のバンドルの依存関係として、このプロパティーでバンドルを解決します。GVK は Kubernetes GVK の検証に準拠する必要があります。

例2.6 olm.gvk プロパティー

2.2.2.3.3. olm.package.required

olm.package.required プロパティーは、このバンドルが必要な別のパッケージのパッケージ名とバージョン範囲を定義します。バンドルにリストされている必要なパッケージプロパティーごとに、OLM は、リストされているパッケージのクラスターに必要なバージョン範囲で Operator がインストールされていることを確認します。versionRange フィールドは有効なセマンティクスバージョン (semver) の範囲である必要があります。

例2.7 olm.package.required プロパティー

2.2.2.3.4. olm.gvk.required

olm.gvk.required プロパティーは、このバンドルが必要とする Kubernetes API の group/version/kind(GVK) を定義します。バンドルにリストされている必要な GVK プロパティーごとに、OLM は、提供する Operator がクラスターにインストールされていることを確認します。GVK は Kubernetes GVK の検証に準拠する必要があります。

例2.8 olm.gvk.required プロパティー

2.2.2.4. カタログの例

ファイルベースのカタログを使用すると、カタログメンテナーは Operator のキュレーションおよび互換性に集中できます。Operator の作成者は Operators 用に Operator 固有のカタログをすでに生成しているので、カタログメンテナーは、各 Operator カタログをカタログのルートディレクトリーのサブディレクトリーにレンダリングしてビルドできます。

ファイルベースのカタログをビルドする方法は多数あります。以下の手順は、単純なアプローチの概要を示しています。

カタログの設定ファイルを 1 つ維持し、カタログ内に Operator ごとにイメージの参照を含めます。

カタログ設定ファイルのサンプル

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 設定ファイルを解析し、その参照から新規カタログを作成するスクリプトを実行します。

スクリプトの例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.2.5. ガイドライン

ファイルベースのカタログを維持する場合には、以下のガイドラインを考慮してください。

2.2.2.5.1. イミュータブルなバンドル

Operator Lifecycle Manager(OLM) に関する一般的なアドバイスとして、バンドルイメージとそのメタデータをイミュータブルとして処理する必要がある点があります。

破損したバンドルがカタログにプッシュされている場合には、少なくとも 1 人のユーザーがそのバンドルにアップグレードしたと想定する必要があります。このような想定に基づいて、破損したバンドルをインストールしたユーザーがアップグレードを確実に受け取れるように、破損したバンドルのアップグレードパスを使用して別のバンドルをリリースする必要があります。OLM は、カタログでバンドルの内容が更新された場合に、インストールされたバンドルは再インストールされません。

ただし、カタログメタデータの変更が推奨される場合があります。

-

チャネルプロモーション: バンドルをすでにリリースし、後で別のチャネルに追加することにした場合は、バンドルのエントリーを別の

olm.channelBlob に追加できます。 -

新規アップグレードパス:

1.2.zバンドルバージョンを新たにリリースしたが (例:1.2.4)、1.3.0がすでにリリースされている場合は、1.2.4をスキップするように1.3.0のカタログメタデータを更新できます。

2.2.2.5.2. ソース制御

カタログメタデータはソースコントロールに保存され、信頼できる情報源として処理される必要があります。以下の手順で、カタログイメージを更新する必要があります。

- ソース制御されたカタログディレクトリーを新規コミットを使用して更新します。

-

カタログイメージをビルドし、プッシュします。ユーザーがカタログが利用可能になり次第更新を受信できるように、一貫性のあるタグ付け (

:latestor:<target_cluster_version>) を使用します。

2.2.2.6. CLI の使用

opm CLI を使用してファイルベースのカタログを作成する方法は、カスタムカタログの管理 を参照してください。

ファイルベースのカタログの管理に関連する opm CLI コマンドの参考情報は、CLI ツール を参照してください。

2.2.2.7. 自動化

Operator の作成者およびカタログメンテナーは、CI/CD ワークフローを使用してカタログのメンテナンスを自動化することが推奨されます。カタログメンテナーは、GitOps 自動化をビルドして以下のタスクを実行し、これをさらに向上させることができます。

- パッケージのイメージ参照の更新など、プル要求 (PR) の作成者が要求された変更を実行できることを確認します。

-

カタログの更新で

opm validateコマンドが指定されていることを確認します。 - 更新されたバンドルまたはカタログイメージの参照が存在し、カタログイメージがクラスターで正常に実行され、そのパッケージの Operators が正常にインストールされることを確認します。

- 以前のチェックに合格した PR を自動的にマージします。

- カタログイメージを自動的にもう一度ビルドして公開します。

2.3. 一般的な Operator Framework 用語

このトピックでは、Operator Lifecycle Manager (OLM) を含む Operator Framework に関連する一般的な用語の用語集を提供します。

2.3.1. バンドル

Bundle Format では、バンドル は Operator CSV、マニフェスト、およびメタデータのコレクションです。さらに、それらはクラスターにインストールできる一意のバージョンの Operator を形成します。

2.3.2. バンドルイメージ

Bundle Format では、バンドルイメージ は Operator マニフェストからビルドされ、1 つのバンドルが含まれるコンテナーイメージです。バンドルイメージは、Quay.io または DockerHub などの Open Container Initiative (OCI) 仕様コンテナーレジストリーによって保存され、配布されます。

2.3.3. カタログソース

カタログソース は、OLM が Operators およびそれらの依存関係を検出し、インストールするためにクエリーできるメタデータのストアを表します。

2.3.4. チャネル

チャネル は Operator の更新ストリームを定義し、サブスクライバーの更新をロールアウトするために使用されます。ヘッドはそのチャネルの最新バージョンを参照します。たとえば stable チャネルには、Operator のすべての安定したバージョンが最も古いものから最新のものへと編成されます。

Operator には複数のチャネルを含めることができ、特定のチャネルへのサブスクリプションのバインドはそのチャネル内の更新のみを検索します。

2.3.5. チャネルヘッド

チャネルヘッド は、特定のチャネル内の最新の既知の更新を指します。

2.3.6. クラスターサービスバージョン

クラスターサービスバージョン (CSV) は、クラスターでの Operator の実行に使用される Operator メタデータから作成される YAML マニフェストです。これは、ユーザーインターフェイスにロゴ、説明、およびバージョンなどの情報を設定するために使用される Operator コンテナーイメージに伴うメタデータです。

CSV は、Operator が必要とする RBAC ルールやそれが管理したり、依存したりするカスタムリソース (CR) などの Operator の実行に必要な技術情報の情報源でもあります。

2.3.7. 依存関係

Operator はクラスターに存在する別の Operator への 依存関係 を持つ場合があります。たとえば、Vault Operator にはそのデータ永続層に etcd Operator への依存関係があります。

OLM は、インストールフェーズで指定されたすべてのバージョンの Operators および CRD がクラスターにインストールされていることを確認して依存関係を解決します。この依存関係は、必要な CRD API を満たすカタログの Operator を検索し、インストールすることで解決され、パッケージまたはバンドルには関連しません。

2.3.8. エクステンション

拡張機能により、クラスター管理者は Red Hat OpenShift Service on AWS クラスター上のユーザーの機能を拡張できます。拡張機能は Operator Lifecycle Manager (OLM) v1 によって管理されます。

ClusterExtension API は、ユーザー向け API を単一のオブジェクトに統合することで、registry+v1 バンドル形式を使用した Operators を含むインストール済み拡張機能の管理を効率化します。管理者と SRE は、この API を使用してプロセスを自動化し、GitOps の原則に基づき望ましい状態を定義できます。

2.3.9. インデックスイメージ

Bundle Format で、インデックスイメージ は、すべてのバージョンの CSV および CRD を含む Operator バンドルに関する情報が含まれるデータベースのイメージ (データベーススナップショット) を指します。このインデックスは、クラスターで Operators の履歴をホストでき、opm CLI ツールを使用して Operators を追加または削除することで維持されます。

2.3.10. インストール計画

インストール計画 は、CSV を自動的にインストールするか、アップグレードするために作成されるリソースの計算された一覧です。

2.3.11. マルチテナントへの対応

Red Hat OpenShift Service on AWS の テナント は、デプロイされた一連のワークロードに対する共通のアクセス権と権限を共有するユーザーまたはユーザーのグループであり、通常は namespace またはプロジェクトで表されます。テナントを使用して、異なるグループまたはチーム間に一定レベルの分離を提供できます。

クラスターが複数のユーザーまたはグループによって共有されている場合、マルチテナント クラスターと見なされます。

2.3.12. Operator

Operators は、Kubernetes アプリケーションをパッケージ化し、デプロイし、管理する方法です。Kubernetes アプリケーションは、Kubernetes にデプロイされ、Kubernetes API および kubectl または oc ツールを使用して管理されるアプリケーションです。

Operator Lifecycle Manager (OLM) v1 では、ClusterExtension API により、registry+v1 バンドル形式を使用した Operators を含むインストール済み拡張機能の管理が効率化されます。

2.3.13. Operator グループ

Operator グループ は、OperatorGroup オブジェクトと同じ namespace にデプロイされたすべての Operators を、namespace のリストまたはクラスター全体でそれらの CR を監視できるように設定します。

2.3.14. Package

Bundle Format で、パッケージ は Operator のリリースされたすべての履歴をそれぞれのバージョンで囲むディレクトリーです。Operator のリリースされたバージョンは、CRD と共に CSV マニフェストに記述されます。

2.3.15. レジストリー

レジストリー は、Operators のバンドルイメージを保存するデータベースで、それぞれにすべてのチャネルの最新バージョンおよび過去のバージョンすべてが含まれます。

2.3.16. サブスクリプション

サブスクリプション は、パッケージのチャネルを追跡して CSV を最新の状態に保ちます。

2.3.17. 更新グラフ

更新グラフ は、他のパッケージ化されたソフトウェアの更新グラフと同様に、CSV の複数のバージョンを 1 つにまとめます。Operators を順番にインストールすることも、特定のバージョンを省略することもできます。更新グラフは、新しいバージョンが追加されている状態でヘッドでのみ拡張することが予想されます。

更新エッジ または 更新パス とも呼ばれます。

2.4. Operator Lifecycle Manager (OLM)

2.4.1. Operator Lifecycle Manager の概念およびリソース

このガイドでは、Red Hat OpenShift Service on AWS の Operator Lifecycle Manager (OLM) を支える概念の概要を説明します。

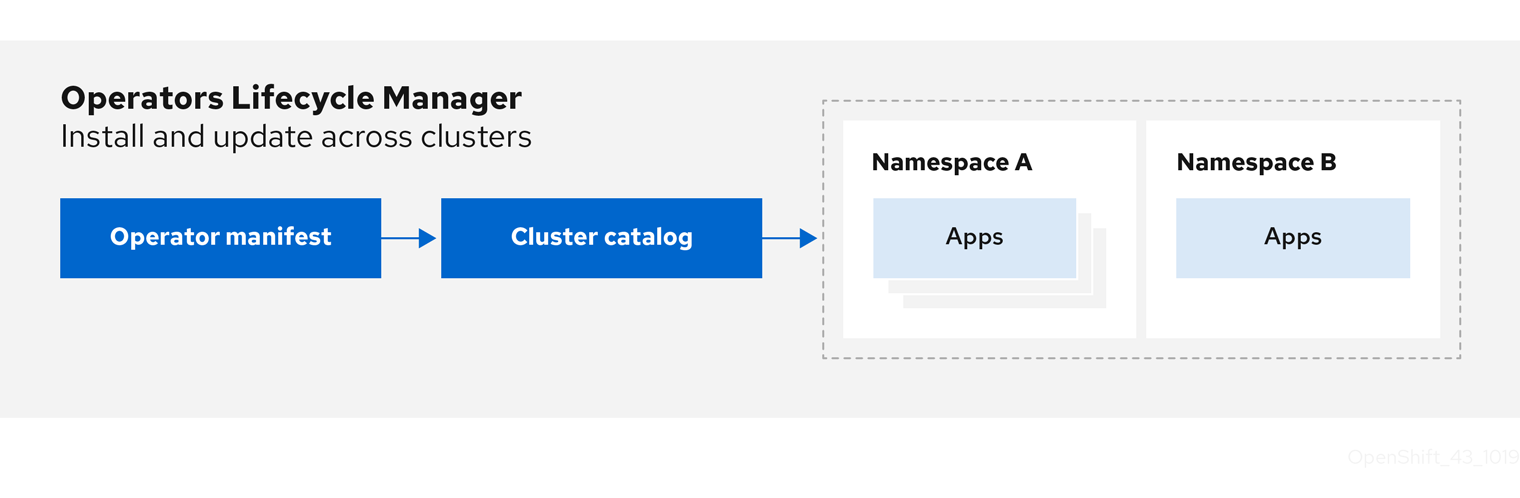

2.4.1.1. Operator Lifecycle Manager (OLM) Classic とは

Operator Lifecycle Manager (OLM) Classic を使用することにより、ユーザーは Kubernetes ネイティブアプリケーション (Operator) および Red Hat OpenShift Service on AWS クラスター全体で実行される関連サービスにインストール、更新、およびそのライフサイクルの管理を実行できます。これは、Operators を効果的かつ自動化された拡張可能な方法で管理するために設計されたオープンソースツールキットの Operator Framework の一部です。

図2.2 OLM (Classic) ワークフロー

OLM は Red Hat OpenShift Service on AWS でデフォルトで実行されます。これは、dedicated-admin ロールを持つ管理者が、クラスターで実行されている Operator のインストール、アップグレード、アクセス付与を行う際に役立ちます。Red Hat OpenShift Service on AWS Web コンソールは、dedicated-admin 管理者が Operator をインストールしたり、クラスターで利用可能な Operator のカタログを使用できるように特定のプロジェクトアクセスを付与したりするのに使用する管理画面を提供します。

開発者の場合は、セルフサービスを使用することで、専門的な知識がなくてもデータベースのインスタンスのプロビジョニングや設定、またモニタリング、ビッグデータサービスなどを実行できます。Operator にそれらに関するナレッジが織り込まれているためです。

2.4.1.2. OLM リソース

以下のカスタムリソース定義 (CRD) は Operator Lifecycle Manager (OLM) によって定義され、管理されます。

| リソース | 短縮名 | 説明 |

|---|---|---|

|

|

| アプリケーションメタデータ:例: 名前、バージョン、アイコン、必須リソース。 |

|

|

| CSV、CRD、およびアプリケーションを定義するパッケージのリポジトリー。 |

|

|

| パッケージのチャネルを追跡して CSV を最新の状態に保ちます。 |

|

|

| CSV を自動的にインストールするか、アップグレードするために作成されるリソースの計算された一覧。 |

|

|

|

|

|

| - |

OLM とそれが管理する Operator との間で通信チャネルを作成します。Operators は |

2.4.1.2.1. クラスターサービスバージョン

クラスターサービスバージョン (CSV) は、Red Hat OpenShift Service on AWS クラスター上で実行中の Operator の特定バージョンを表します。これは、クラスターでの Operator Lifecycle Manager (OLM) の Operator の実行に使用される Operator メタデータから作成される YAML マニフェストです。

OLM は Operator に関するこのメタデータを要求し、これがクラスターで安全に実行できるようにし、Operator の新規バージョンが公開される際に更新を適用する方法に関する情報を提供します。これは従来のオペレーティングシステムのソフトウェアのパッケージに似ています。OLM のパッケージ手順を、rpm、deb、または apk バンドルを作成するステージとして捉えることができます。

CSV には、ユーザーインターフェイスに名前、バージョン、説明、ラベル、リポジトリーリンクおよびロゴなどの情報を設定するために使用される Operator コンテナーイメージに伴うメタデータが含まれます。

CSV は、Operator が管理したり、依存したりするカスタムリソース (CR)、RBAC ルール、クラスター要件、およびインストールストラテジーなどの Operator の実行に必要な技術情報の情報源でもあります。この情報は OLM に対して必要なリソースの作成方法と、Operator をデプロイメントとしてセットアップする方法を指示します。

2.4.1.2.2. カタログソース

カタログソース は、通常コンテナーレジストリーに保存されている インデックスイメージ を参照してメタデータのストアを表します。Operator Lifecycle Manager(OLM) はカタログソースをクエリーし、Operators およびそれらの依存関係を検出してインストールします。Red Hat OpenShift Service on AWS Web コンソールのソフトウェアカタログには、カタログソースによって提供される Operator も表示されます。

クラスター管理者は、Web コンソールの Administration → Cluster Settings → Configuration → OperatorHub ページを使用して、クラスターで有効なログソースにより提供される Operators の詳細一覧を表示できます。

CatalogSource オブジェクトの spec は、Pod の構築方法、または Operator Registry gRPC API を提供するサービスとの通信方法を示します。

例2.9 CatalogSource オブジェクトの例

- 1

CatalogSourceオブジェクトの名前。この値は、要求された namespace で作成される、関連の Pod 名の一部としても使用されます。- 2

- カタログを作成する namespace。カタログを全 namespace のクラスター全体で利用可能にするには、この値を

openshift-marketplaceに設定します。Red Hat が提供するデフォルトのカタログソースもopenshift-marketplacenamespace を使用します。それ以外の場合は、値を特定の namespace に設定し、Operator をその namespace でのみ利用可能にします。 - 3

- 任意: クラスターのアップグレードにより、Operator のインストールがサポートされていない状態になったり、更新パスが継続されなかったりする可能性を回避するために、クラスターのアップグレードの一環として、Operator カタログのインデックスイメージのバージョンを自動的に変更するように有効化することができます。

olm.catalogImageTemplateアノテーションをインデックスイメージ名に設定し、イメージタグのテンプレートを作成する際に、1 つ以上の Kubernetes クラスターバージョン変数を使用します。アノテーションは、実行時にspec.imageフィールドを上書きします。詳細は、「カスタムカタログソースのイメージテンプレート」のセクションを参照してください。 - 4

- Web コンソールおよび CLI でのカタログの表示名。

- 5

- カタログのインデックスイメージ。オプションで、

olm.catalogImageTemplateアノテーションを使用して実行時のプル仕様を設定する場合には、省略できます。 - 6

- カタログソースの重み。OLM は重みを使用して依存関係の解決時に優先順位付けします。重みが大きい場合は、カタログが重みの小さいカタログよりも優先されることを示します。

- 7

- ソースタイプには以下が含まれます。

-

image参照のあるgrpc: OLM はイメージをポーリングし、Pod を実行します。これにより、準拠 API が提供されることが予想されます。 -

addressフィールドのあるgrpc: OLM は所定アドレスでの gRPC API へのアクセスを試行します。これはほとんどの場合使用することができません。 -

configmap: OLM は設定マップデータを解析し、gRPC API を提供できる Pod を実行します。

-

- 8

legacyまたはrestrictedの値を指定します。フィールドが設定されていない場合、デフォルト値はlegacyです。今後の Red Hat OpenShift Service on AWS リリースでは、デフォルト値がrestrictedになる予定です。restricted権限でカタログを実行できない場合は、このフィールドを手動でlegacyに設定することを推奨します。- 9

- オプション:

grpcタイプのカタログソースの場合は、spec.imageでコンテンツを提供する Pod のデフォルトのノードセレクターをオーバーライドします (定義されている場合)。 - 10

- オプション:

grpcタイプのカタログソースの場合は、spec.imageでコンテンツを提供する Pod のデフォルトの優先度クラス名をオーバーライドします (定義されている場合)。Kubernetes は、デフォルトで優先度クラスsystem-cluster-criticalおよびsystem-node-criticalを提供します。フィールドを空 ("") に設定すると、Pod にデフォルトの優先度が割り当てられます。他の優先度クラスは、手動で定義できます。 - 11

- オプション:

grpcタイプのカタログソースの場合は、spec.imageでコンテンツを提供する Pod のデフォルトの Toleration をオーバーライドします (定義されている場合)。 - 12

- 最新の状態を維持するために、特定の間隔で新しいバージョンの有無を自動的にチェックします。

- 13

- カタログ接続が最後に監視された状態。以下に例を示します。

-

READY: 接続が正常に確立されました。 -

CONNECTING: 接続が確立中です。 -

TRANSIENT_FAILURE: タイムアウトなど、接続の確立時一時的な問題が発生しました。状態は最終的にCONNECTINGに戻り、再試行されます。

詳細は、gRPC ドキュメントの 接続の状態 を参照してください。

-

- 14

- カタログイメージを保存するコンテナーレジストリーがポーリングされ、イメージが最新の状態であることを確認します。

- 15

- カタログの Operator Registry サービスのステータス情報。

サブスクリプションの CatalogSource オブジェクトの name を参照すると、要求された Operator を検索する場所を、OLM に指示します。

例2.10 カタログソースを参照する Subscription オブジェクトの例

2.4.1.2.2.1. カスタムカタログソースのイメージテンプレート

基礎となるクラスターとの Operator との互換性は、さまざまな方法でカタログソースにより表現できます。1 つの方法は、特定のプラットフォームリリース (Red Hat OpenShift Service on AWS など) 用に特別に作成されたインデックスイメージのイメージタグを特定することです。この方法は、Red Hat 提供のデフォルトのカタログソースに使用されています。

クラスターのアップグレード時に、Red Hat が提供するデフォルトのカタログソースのインデックスイメージのタグは、Operator Lifecycle Manager (OLM) が最新版のカタログをプルするように、Cluster Version Operator (CVO) により自動更新されます。たとえば、Red Hat OpenShift Service on AWS 4.19 から 4 へのアップグレード時に、redhat-operators カタログの CatalogSource オブジェクトの spec.image フィールドは次のように更新されます。

registry.redhat.io/redhat/redhat-operator-index:v4.20

registry.redhat.io/redhat/redhat-operator-index:v4.20更新後は次のようになります。

registry.redhat.io/redhat/redhat-operator-index:v4.20

registry.redhat.io/redhat/redhat-operator-index:v4.20ただし、CVO ではカスタムカタログのイメージタグは自動更新されません。クラスターのアップグレード後、ユーザーが互換性があり、サポート対象の Operator のインストールを確実に行えるようにするには、カスタムカタログも更新して、更新されたインデックスイメージを参照する必要があります。

Red Hat OpenShift Service on AWS 4.9 以降、クラスター管理者は、カスタムカタログの CatalogSource オブジェクトの olm.catalogImageTemplate アノテーションを、テンプレートを含むイメージ参照に追加できます。以下の Kubernetes バージョン変数は、テンプレートで使用できるようにサポートされています。

-

kube_major_version -

kube_minor_version -

kube_patch_version

Red Hat OpenShift Service on AWS クラスターのバージョンではなく、Kubernetes クラスターのバージョンを指定する必要があります。Red Hat OpenShift Service on AWS クラスターのバージョンは、現在テンプレートに使用できないためです。

更新された Kubernetes バージョンを指定するタグでインデックスイメージを作成してプッシュしている場合に、このアノテーションを設定すると、カスタムカタログのインデックスイメージのバージョンがクラスターのアップグレード後に自動的に変更されます。アノテーションの値は、CatalogSource オブジェクトの spec.image フィールドでイメージ参照を設定したり、更新したりするために使用されます。こうすることで、サポートなしの状態や、継続する更新パスなしの状態で Operator がインストールされないようにします。

格納されているレジストリーがどれであっても、クラスターのアップグレード時に、クラスターが、更新されたタグを含むインデックスイメージにアクセスできるようにする必要があります。

例2.11 イメージテンプレートを含むカタログソースの例

spec.image フィールドおよび olm.catalogImageTemplate アノテーションの両方が設定されている場合には、spec.image フィールドはアノテーションから解決された値で上書きされます。アノテーションが使用可能なプル仕様に対して解決されない場合は、カタログソースは spec.image 値にフォールバックします。

spec.image フィールドが設定されていない場合に、アノテーションが使用可能なプル仕様に対して解決されない場合は、OLM はカタログソースの調整を停止し、人間が判読できるエラー条件に設定します。

Kubernetes 1.33 を使用する Red Hat OpenShift Service on AWS クラスターの場合、前述の例の olm.catalogImageTemplate アノテーションは次のイメージ参照に解決されます。

quay.io/example-org/example-catalog:v1.33

quay.io/example-org/example-catalog:v1.33

Red Hat OpenShift Service on AWS の今後のリリースに備えて、新しい Red Hat OpenShift Service on AWS バージョンで使用される新しい Kubernetes バージョンを対象とした、カスタムカタログの更新済みインデックスイメージを作成できます。アップグレード前に olm.catalogImageTemplate アノテーションを設定してから、クラスターを新しい Red Hat OpenShift Service on AWS バージョンにアップグレードすると、カタログのインデックスイメージも自動的に更新されます。

2.4.1.2.2.2. カタログの正常性要件

クラスター上の Operator カタログは、インストール解決の観点から相互に置き換え可能です。Subscription オブジェクトは特定のカタログを参照する場合がありますが、依存関係はクラスターのすべてのカタログを使用して解決されます。

たとえば、カタログ A が正常でない場合、カタログ A を参照するサブスクリプションはカタログ B の依存関係を解決する可能性があります。通常、B のカタログ優先度は A よりも低いため、クラスター管理者はこれおを想定していない可能性があります。

その結果、OLM では、特定のグローバル namespace (デフォルトの openshift-marketplace namespace やカスタムグローバル namespace など) を持つすべてのカタログが正常であることが必要になります。カタログが正常でない場合、その共有グローバル namespace 内のすべての Operator のインストールまたは更新操作は、CatalogSourcesUnhealthy 状態で失敗します。正常でない状態でこれらの操作が許可されている場合、OLM はクラスター管理者が想定しない解決やインストールを決定する可能性があります。

クラスター管理者として、正常でないカタログが見つかった際にそのカタログを無効とみなして Operator のインストールを再開する場合は、「カスタムカタログの削除」または「デフォルトのソフトウェアカタログソースの無効化」セクションで、正常でないカタログを削除する方法を確認してください。

2.4.1.2.3. Subscription

サブスクリプション は、Subscription オブジェクトによって定義され、Operator をインストールする意図を表します。これは、Operator をカタログソースに関連付けるカスタムリソースです。

サブスクリプションは、サブスクライブする Operator パッケージのチャネルや、更新を自動または手動で実行するかどうかを記述します。サブスクリプションが自動に設定された場合、Operator Lifecycle Manager (OLM) が Operator を管理し、アップグレードして、最新バージョンがクラスター内で常に実行されるようにします。

Subscription オブジェクトの例

この Subscription オブジェクトは、Operator の名前と namespace、および Operator データのあるカタログを定義します。alpha、beta、または stable などのチャネルは、カタログソースからインストールする必要のある Operator ストリームを判別するのに役立ちます。

サブスクリプションのチャネルの名前は Operators 間で異なる可能性がありますが、命名スキームは指定された Operator 内の一般的な規則に従う必要があります。たとえば、チャネル名は Operator によって提供されるアプリケーションのマイナーリリース更新ストリーム (1.2、1.3) またはリリース頻度 (stable、fast) に基づく可能性があります。

関連するサブスクリプションのステータスを調べると、Operator の新しいバージョンが利用可能になったことを確認できます。これは、Red Hat OpenShift Service on AWS Web コンソールからも簡単に確認できます。currentCSV フィールドに関連付けられる値は OLM に認識される最新のバージョンであり、installedCSV はクラスターにインストールされるバージョンです。

2.4.1.2.4. インストール計画

InstallPlan オブジェクトによって定義される インストール計画 は、Operator Lifecycle Manager(OLM) が特定バージョンの Operator をインストールまたはアップグレードするために作成するリソースのセットを記述します。バージョンはクラスターサービスバージョン (CSV) で定義されます。

Operator、クラスター管理者、または Operator インストールパーミッションが付与されているユーザーをインストールするには、まず Subscription オブジェクトを作成する必要があります。サブスクリプションでは、カタログソースから利用可能なバージョンの Operator のストリームにサブスクライブする意図を表します。次に、サブスクリプションは InstallPlan オブジェクトを作成し、Operator のリソースのインストールを容易にします。

その後、インストール計画は、以下の承認ストラテジーのいずれかをもとに承認される必要があります。

-

サブスクリプションの

spec.installPlanApprovalフィールドがAutomaticに設定されている場合には、インストール計画は自動的に承認されます。 -

サブスクリプションの

spec.installPlanApprovalフィールドがManualに設定されている場合には、インストール計画はクラスター管理者または適切なパーミッションが割り当てられたユーザーによって手動で承認する必要があります。

インストール計画が承認されると、OLM は指定されたリソースを作成し、サブスクリプションで指定された namespace に Operator をインストールします。

例2.12 InstallPlan オブジェクトの例

2.4.1.2.5. Operator グループ

Operator グループ は、OperatorGroup リソースによって定義され、マルチテナント設定を OLM でインストールされた Operators に提供します。Operator グループは、そのメンバー Operators に必要な RBAC アクセスを生成するために使用するターゲット namespace を選択します。

ターゲット namespace のセットは、クラスターサービスバージョン (CSV) の olm.targetNamespaces アノテーションに保存されるコンマ区切りの文字列によって指定されます。このアノテーションは、メンバー Operator の CSV インスタンスに適用され、そのデプロイメントに反映されます。

関連情報

2.4.1.2.6. Operator 条件

Operator のライフサイクル管理のロールの一部として、Operator Lifecycle Manager (OLM) は、Operator を定義する Kubernetes リソースの状態から Operator の状態を推測します。このアプローチでは、Operator が特定の状態にあることをある程度保証しますが、推測できない情報を Operator が OLM と通信して提供する必要がある場合も多々あります。続いて、OLM がこの情報を使用して、Operator のライフサイクルをより適切に管理することができます。

OLM は、Operators が OLM に条件を通信できる OperatorCondition というカスタムリソース定義 (CRD) を提供します。OperatorCondition リソースの Spec.Conditions 配列にある場合に、OLM による Operator の管理に影響するサポートされる条件のセットがあります。

デフォルトでは、Spec.Conditions 配列は、ユーザーによって追加されるか、カスタム Operator ロジックの結果として追加されるまで、OperatorCondition オブジェクトに存在しません。

2.4.2. Operator Lifecycle Manager アーキテクチャー

ここでは、Red Hat OpenShift Service on AWS における Operator Lifecycle Manager (OLM) のコンポーネントアーキテクチャーの概要を説明します。

2.4.2.1. コンポーネントの役割

Operator Lifecycle Manager (OLM) は、OLM Operator および Catalog Operator の 2 つの Operator で構成されています。

OLM Operator と Catalog Operator は、それぞれ OLM フレームワークの基礎となるカスタムリソース定義 (CRD) を管理します。

| リソース | 短縮名 | 所有者 | 説明 |

|---|---|---|---|

|

|

| OLM | アプリケーションのメタデータ: 名前、バージョン、アイコン、必須リソース、インストールなど。 |

|

|

| Catalog | CSV を自動的にインストールするか、アップグレードするために作成されるリソースの計算された一覧。 |

|

|

| Catalog | CSV、CRD、およびアプリケーションを定義するパッケージのリポジトリー。 |

|

|

| Catalog | パッケージのチャネルを追跡して CSV を最新の状態に保つために使用されます。 |

|

|

| OLM |

|

これらの Operators のそれぞれは以下のリソースの作成も行います。

| リソース | 所有者 |

|---|---|

|

| OLM |

|

| |

|

| |

|

| |

|

| Catalog |

|

|

2.4.2.2. OLM Operator

OLM Operator は、CSV で指定された必須リソースがクラスター内にあることが確認された後に CSV リソースで定義されるアプリケーションをデプロイします。

OLM Operator は必須リソースの作成には関与せず、ユーザーが CLI またはカタログ Operator を使用してこれらのリソースを手動で作成することを選択できます。このタスクの分離により、アプリケーションに OLM フレームワークをどの程度活用するかに関連してユーザーによる追加機能の購入を可能にします。

OLM Operator は以下のワークフローを使用します。

- namespace でクラスターサービスバージョン (CSV) の有無を確認し、要件を満たしていることを確認します。

要件が満たされている場合、CSV のインストールストラテジーを実行します。

注記CSV は、インストールストラテジーの実行を可能にするために Operator グループのアクティブなメンバーである必要があります。

2.4.2.3. Catalog Operator

Catalog Operator はクラスターサービスバージョン (CSV) およびそれらが指定する必須リソースを解決し、インストールします。また、カタログソースでチャネル内のパッケージへの更新の有無を確認し、必要な場合はそれらを利用可能な最新バージョンに自動的にアップグレードします。

チャネル内のパッケージを追跡するために、必要なパッケージ、チャネル、および更新のプルに使用する CatalogSource オブジェクトを設定して Subscription オブジェクトを作成できます。更新が見つかると、ユーザーに代わって適切な InstallPlan オブジェクトの namespace への書き込みが行われます。

Catalog Operator は以下のワークフローを使用します。

- クラスターの各カタログソースに接続します。

ユーザーによって作成された未解決のインストール計画の有無を確認し、これがあった場合は以下を実行します。

- 要求される名前に一致する CSV を検索し、これを解決済みリソースとして追加します。

- マネージドまたは必須の CRD のそれぞれについて、これを解決済みリソースとして追加します。

- 必須 CRD のそれぞれについて、これを管理する CSV を検索します。

- 解決済みのインストール計画の有無を確認し、それに関する検出されたすべてのリソースを作成します (ユーザーによって、または自動的に承認される場合)。

- カタログソースおよびサブスクリプションの有無を確認し、それらに基づいてインストール計画を作成します。

2.4.2.4. カタログレジストリー

カタログレジストリーは、クラスター内での作成用に CSV および CRD を保存し、パッケージおよびチャネルに関するメタデータを保存します。

パッケージマニフェスト は、パッケージアイデンティティーを CSV のセットに関連付けるカタログレジストリー内のエントリーです。パッケージ内で、チャネルは特定の CSV を参照します。CSV は置き換え対象の CSV を明示的に参照するため、パッケージマニフェストは Catalog Operator に対し、CSV をチャネル内の最新バージョンに更新するために必要なすべての情報を提供します (各中間バージョンをステップスルー)。

2.4.3. Operator Lifecycle Manager ワークフロー

ここでは、Red Hat OpenShift Service on AWS における Operator Lifecycle Manager (OLM) のワークフローの概要を説明します。

2.4.3.1. OLM での Operator のインストールおよびアップグレードのワークフロー

Operator Lifecycle Manager (OLM) エコシステムでは、以下のリソースを使用して Operator インストールおよびアップグレードを解決します。

-

ClusterServiceVersion(CSV) -

CatalogSource -

Subscription

CSV で定義される Operator メタデータは、カタログソースというコレクションに保存できます。OLM はカタログソースを使用します。これは Operator Registry API を使用して利用可能な Operators やインストールされた Operators のアップグレードをクエリーします。

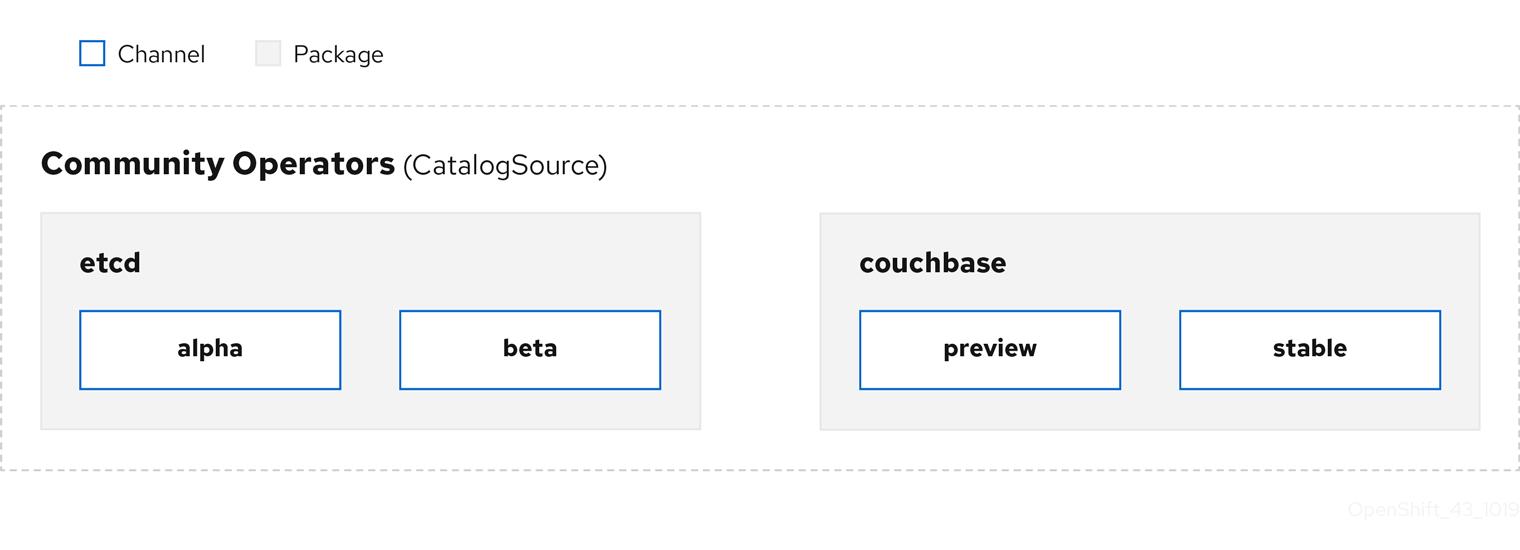

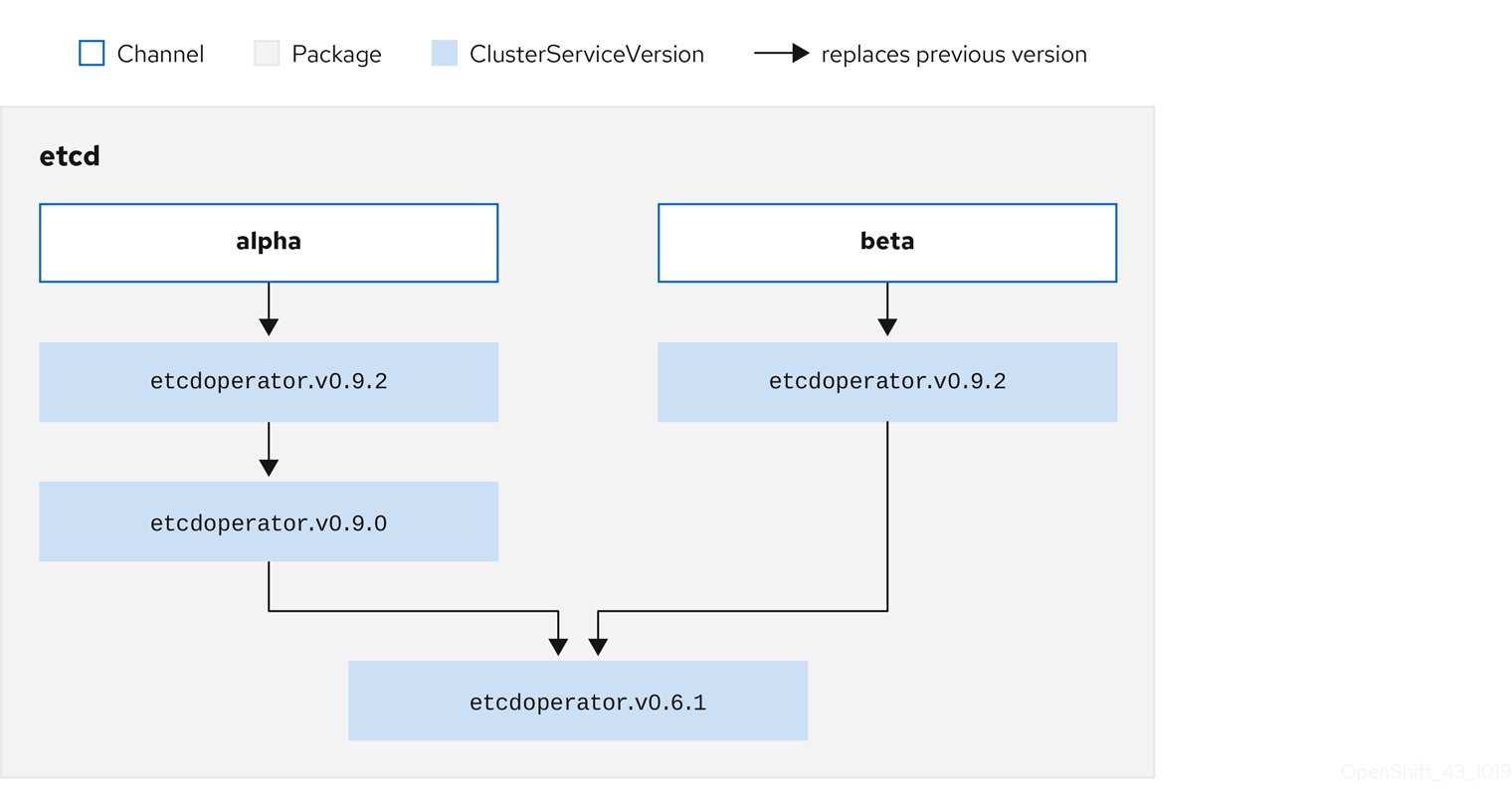

図2.3 カタログソースの概要

カタログソース内では、Operator は パッケージ と、チャネル と呼ばれる更新のストリームに編成されています。これは、Red Hat OpenShift Service on AWS や、Web ブラウザーなどの継続的なリリースサイクルを持つその他のソフトウェアでもよく見られる更新パターンです。

図2.4 カタログソースのパッケージおよびチャネル

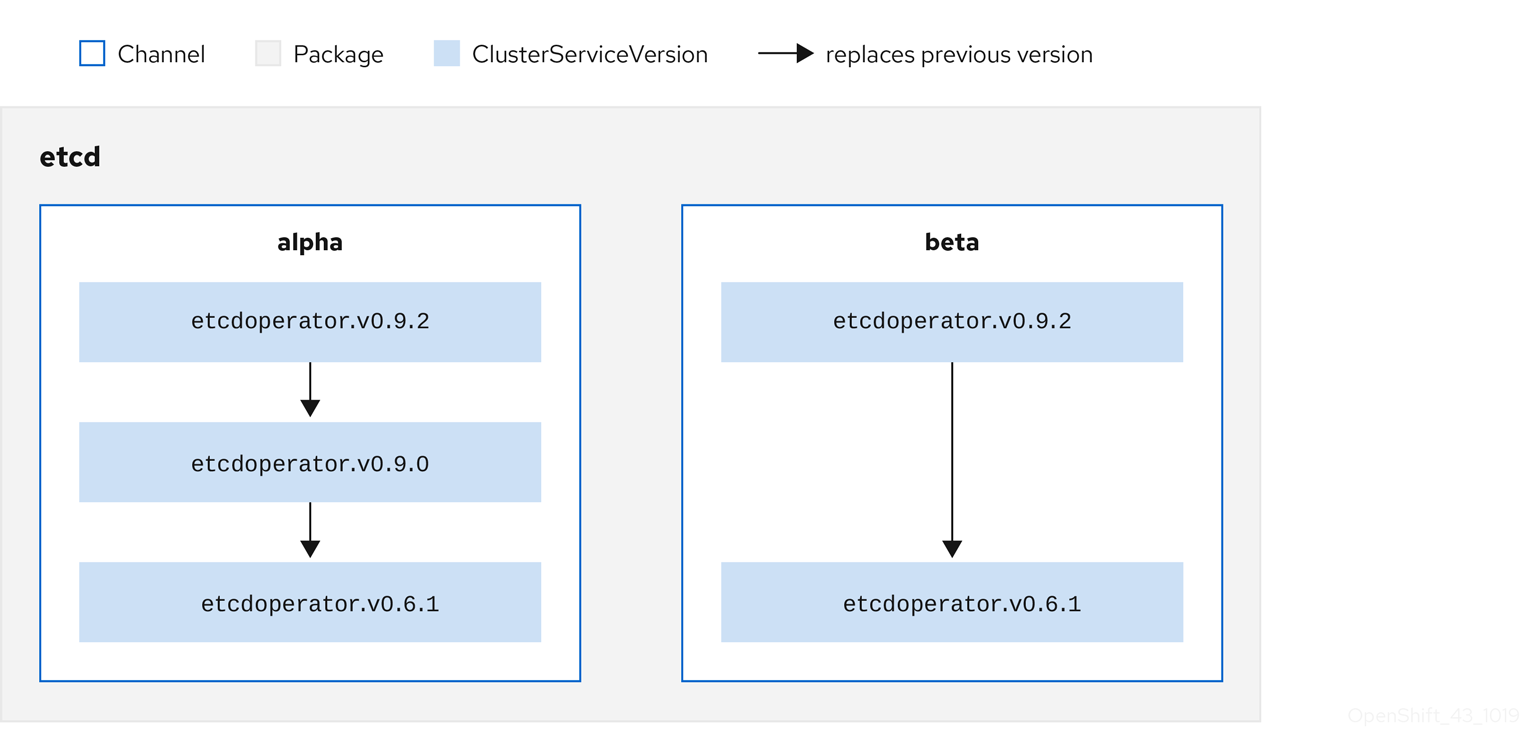

ユーザーは サブスクリプション の特定のカタログソースの特定のパッケージおよびチャネルを指定できます (例: etcd パッケージおよびその alpha チャネル)。サブスクリプションが namespace にインストールされていないパッケージに対して作成されると、そのパッケージの最新 Operator がインストールされます。

OLM では、バージョンの比較が意図的に避けられます。そのため、所定の catalog → channel → package パスから利用可能な "latest" または "newest" Operator が必ずしも最も高いバージョン番号である必要はありません。これは Git リポジトリーの場合と同様に、チャネルの head リファレンスとして見なされます。

各 CSV には、これが置き換える Operator を示唆する replaces パラメーターがあります。これにより、OLM でクエリー可能な CSV のグラフが作成され、更新がチャネル間で共有されます。チャネルは、更新グラフのエントリーポイントと見なすことができます。

図2.5 利用可能なチャネル更新に関する OLM グラフ

パッケージのチャネルの例

カタログソース、パッケージ、チャネルおよび CSV がある状態で、OLM が更新のクエリーを実行できるようにするには、カタログが入力された CSV の置き換え (replaces) を実行する単一 CSV を明確にかつ確定的に返すことができる必要があります。

2.4.3.1.1. アップグレードパスの例

アップグレードシナリオのサンプルについて、CSV バージョン 0.1.1 に対応するインストールされた Operator を見てみましょう。OLM はカタログソースをクエリーし、新規 CSV バージョン 0.1.3 について、サブスクライブされたチャネルのアップグレードを検出します。これは、古いバージョンでインストールされていない CSV バージョン 0.1.2 を置き換えます。その後、さらに古いインストールされた CSV バージョン 0.1.1 を置き換えます。

OLM は、チャネルヘッドから CSV で指定された replaces フィールドで以前のバージョンに戻り、アップグレードパス 0.1.3 → 0.1.2 → 0.1.1 を判別します。矢印の方向は前者が後者を置き換えることを示します。OLM は、チャネルヘッドに到達するまで Operator を 1 バージョンずつアップグレードします。

このシナリオでは、OLM は Operator バージョン 0.1.2 をインストールし、既存の Operator バージョン 0.1.1 を置き換えます。その後、Operator バージョン 0.1.3 をインストールし、直前にインストールされた Operator バージョン 0.1.2 を置き換えます。この時点で、インストールされた Operator のバージョン 0.1.3 はチャネルヘッドに一致し、アップグレードは完了します。

2.4.3.1.2. アップグレードの省略

OLM のアップグレードの基本パスは以下の通りです。

- カタログソースは Operator への 1 つ以上の更新によって更新されます。

- OLM は、カタログソースに含まれる最新バージョンに到達するまで、Operator のすべてのバージョンを横断します。

ただし、この操作の実行は安全でない場合があります。公開されているバージョンの Operator がクラスターにインストールされていない場合、そのバージョンによって深刻な脆弱性が導入される可能性があるなどの理由で、その Operator をクラスターにインストールできないことがあります。

この場合、OLM は以下の 2 つのクラスターの状態を考慮に入れて、それらの両方に対応する更新グラフを提供する必要があります。

- "問題のある" 中間 Operator がクラスターによって確認され、かつインストールされている。

- "問題のある" 中間 Operator がクラスターにまだインストールされていない。

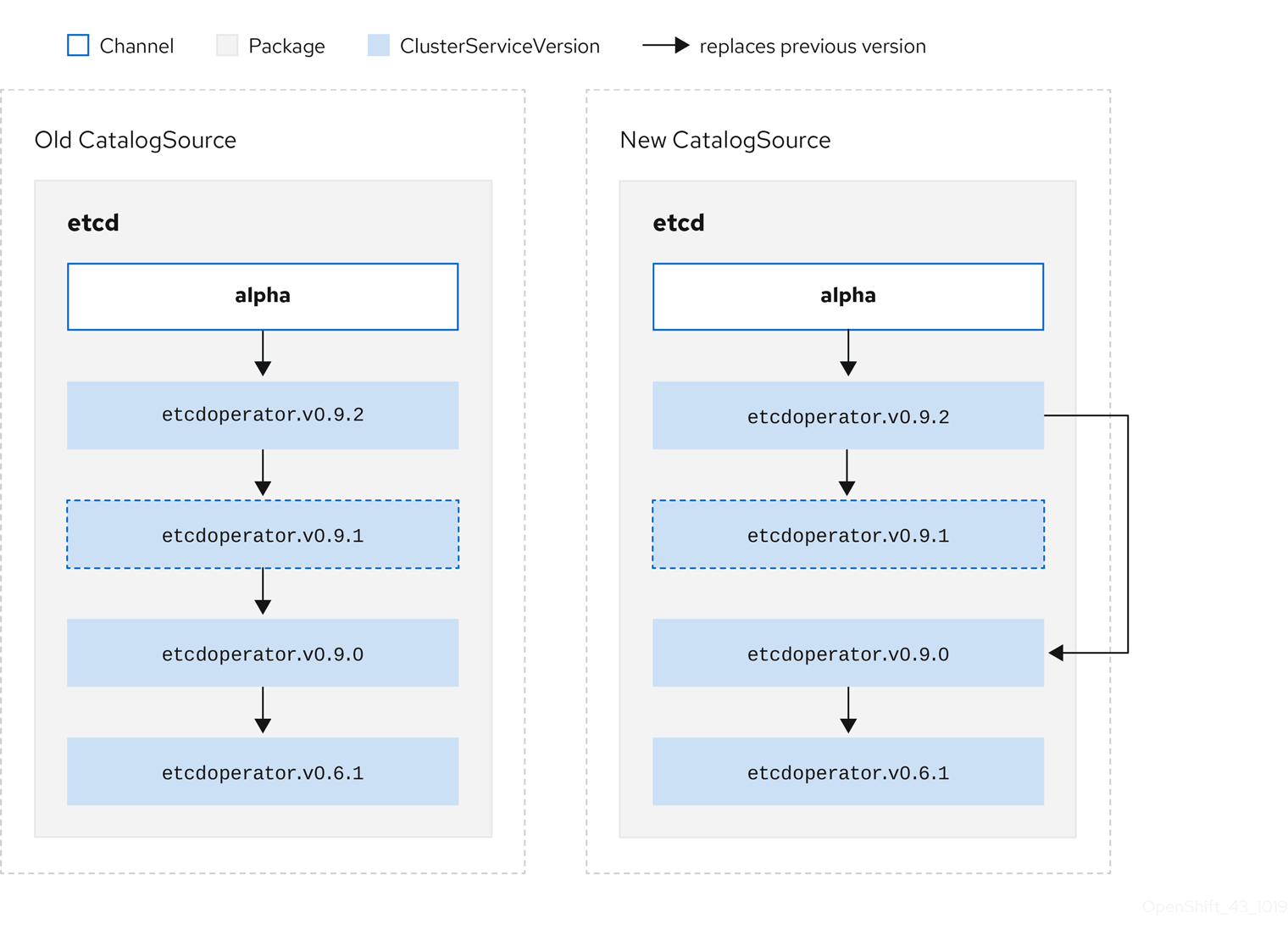

OLM は、新規カタログを送り、省略された リリースを追加することで、クラスターの状態や問題のある更新が発見されたかどうかにかかわらず、単一の固有の更新を常に取得することができます。

省略されたリリースの CSV 例

古い CatalogSource および 新規 CatalogSource に関する以下の例を見てみましょう。

図2.6 更新のスキップ

このグラフは、以下を示しています。

- 古い CatalogSource の Operator には、新規 CatalogSource の単一の置き換えがある。

- 新規 CatalogSource の Operator には、新規 CatalogSource の単一の置き換えがある。

- 問題のある更新がインストールされていない場合、これがインストールされることはない。

2.4.3.1.3. 複数の Operators の置き換え

前述の方法で 新規 CatalogSource を作成するには、ある Operator を置き換えつつ (replace)、複数バージョンをスキップ (skip) できる CSV を公開する必要があります。これは、skipRange アノテーションを使用して実行できます。

olm.skipRange: <semver_range>

olm.skipRange: <semver_range>

ここで <semver_range> には、semver ライブラリー でサポートされるバージョン範囲の形式が使用されます。

カタログで更新を検索する場合、チャネルのヘッドに skipRange アノテーションがあり、現在インストールされている Operator にその範囲内のバージョンフィールドがある場合、OLM はチャネル内の最新エントリーに対して更新されます。

以下は動作が実行される順序になります。

-

サブスクリプションの

sourceNameで指定されるソースのチャネルヘッド (省略する他の条件が満たされている場合)。 -

sourceNameで指定されるソースの現行バージョンを置き換える次の Operator。 - サブスクリプションに表示される別のソースのチャネルヘッド (省略する他の条件が満たされている場合)。

- サブスクリプションに表示されるソースの現行バージョンを置き換える次の Operator。

skipRange を含む CSV の例

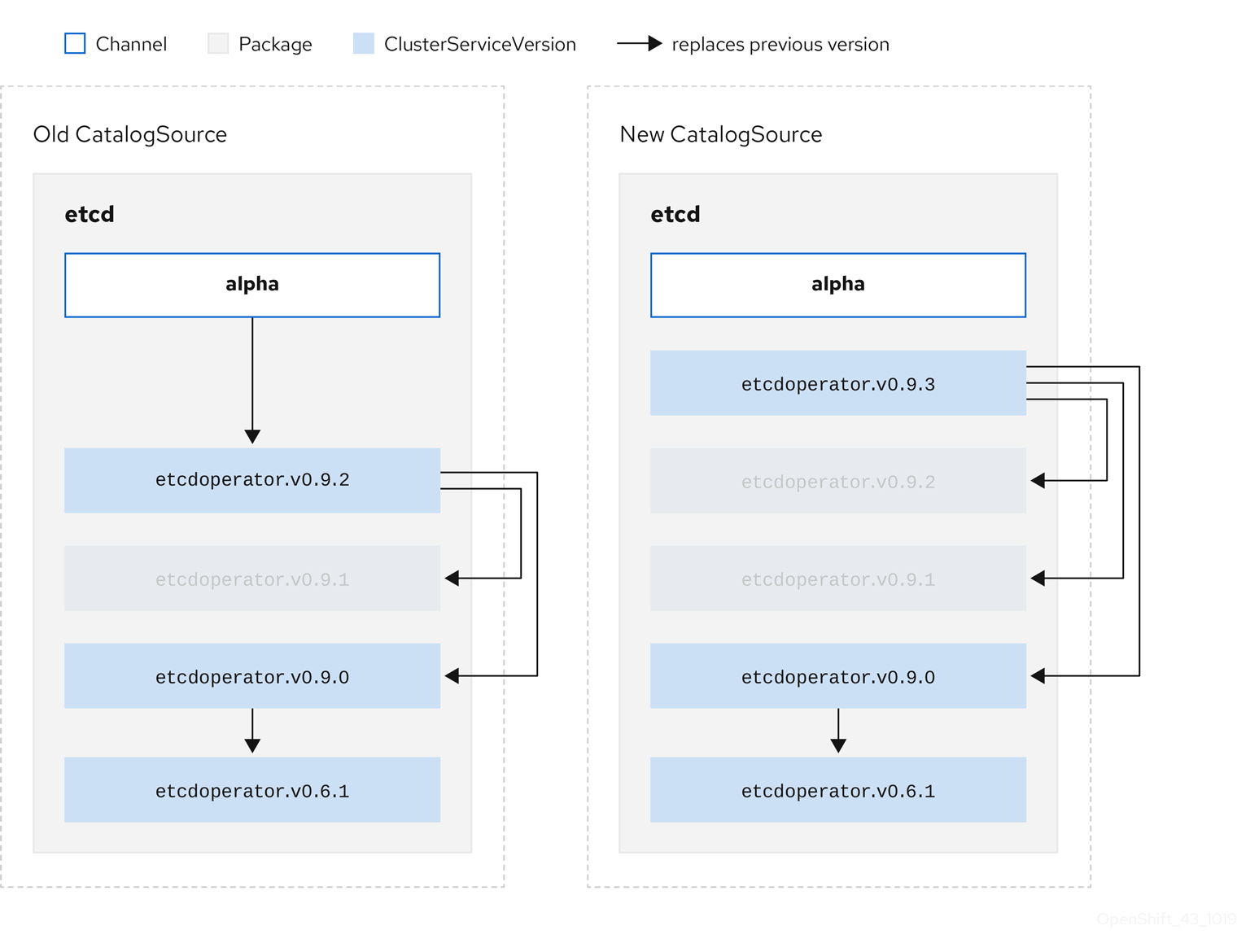

2.4.3.1.4. z-stream サポート

z-stream またはパッチリリースは、同じマイナーバージョンの以前のすべての z-stream リリースを置き換える必要があります。OLM は、メジャー、マイナーまたはパッチバージョンを考慮せず、カタログ内で正確なグラフのみを作成する必要があります。

つまり、OLM では 古い CatalogSource のようにグラフを使用し、以前と同様に 新規 CatalogSource にあるようなグラフを生成する必要があります。

図2.7 複数 Operators の置き換え

このグラフは、以下を示しています。

- 古い CatalogSource の Operator には、新規 CatalogSource の単一の置き換えがある。

- 新規 CatalogSource の Operator には、新規 CatalogSource の単一の置き換えがある。

- 古い CatalogSource の z-stream リリースは、新規 CatalogSource の最新 z-stream リリースに更新される。

- 使用不可のリリースは "仮想" グラフノードと見なされる。それらのコンテンツは存在する必要がなく、レジストリーはグラフが示すように応答することのみが必要になります。

2.4.4. Operator Lifecycle Manager の依存関係の解決

ここでは、Red Hat OpenShift Service on AWS における Operator Lifecycle Manager (OLM) を使用した依存関係の解決とカスタムリソース定義 (CRD) のアップグレードライフサイクルの概要を説明します。

2.4.4.1. 依存関係の解決

Operator Lifecycle Manager (OLM) は、実行中の Operators の依存関係の解決とアップグレードのライフサイクルを管理します。多くの場合、OLM が直面する問題は、yum や rpm などの他のシステムまたは言語パッケージマネージャーと同様です。

ただし、OLM にはあるものの、通常同様のシステムにはない 1 つの制約があります。Operators は常に実行されており、OLM は相互に機能しない Operators のセットの共存を防ごうとします。

その結果、以下のシナリオで OLM を使用しないでください。

- 提供できない API を必要とする Operators のセットのインストール

- Operator と依存関係のあるものに障害を発生させる仕方での Operator の更新

これは、次の 2 種類のデータで可能になります。

| プロパティー | Operator に関する型付きのメタデータ。これは、依存関係のリゾルバーで Operator の公開インターフェイスを構成します。例としては、Operator が提供する API の group/version/kind (GVK) や Operator のセマンティックバージョン (semver) などがあります。 |

| 制約または依存関係 | ターゲットクラスターにすでにインストールされているかどうかに関係なく、他の Operators が満たす必要のある Operator の要件。これらは、使用可能なすべての Operators に対するクエリーまたはフィルターとして機能し、依存関係の解決およびインストール中に選択を制限します。クラスターで特定の API が利用できる状態にする必要がある場合や、特定のバージョンに特定の Operator をインストールする必要がある場合など、例として挙げられます。 |

OLM は、これらのプロパティーと制約をブール式のシステムに変換して SAT ソルバーに渡します。これは、ブールの充足可能性を確立するプログラムであり、インストールする Operators を決定する作業を行います。

2.4.4.2. Operator のプロパティー

カタログ内の Operators にはすべて、次のプロパティーが含まれます。

olm.package- パッケージの名前と Operator のバージョンを含めます。

olm.gvk- クラスターサービスバージョン (CSV) から提供された API ごとに 1 つのプロパティー

追加のプロパティーは、Operator バンドルの metadata/ ディレクトリーに properties.yaml ファイルを追加して、Operator 作成者が直接宣言することもできます。

任意のプロパティーの例

properties:

- type: olm.kubeversion

value:

version: "1.16.0"

properties:

- type: olm.kubeversion

value:

version: "1.16.0"2.4.4.2.1. 任意のプロパティー

Operator の作成者は、Operator バンドルの metadata/ ディレクトリーにある properties.yaml ファイルで任意のプロパティーを宣言できます。これらのプロパティーは、実行時に Operator Lifecycle Manager (OLM) リゾルバーへの入力として使用されるマップデータ構造に変換されます。

これらのプロパティーはリゾルバーには不透明です。リゾルバーはプロパティーを理解しませんが、これらのプロパティーに対する一般的な制約を評価して、プロパティーリストを指定することで制約を満たすことができるかどうかを判断します。

任意のプロパティーの例

この構造を使用して、ジェネリック制約の Common Expression Language (CEL) 式を作成できます。

2.4.4.3. Operator の依存関係

Operator の依存関係は、バンドルの metadata/ フォルダー内の dependencies.yaml ファイルに一覧表示されます。このファイルはオプションであり、現時点では明示的な Operator バージョンの依存関係を指定するためにのみ使用されます。

依存関係の一覧には、依存関係の内容を指定するために各項目の type フィールドが含まれます。次のタイプの Operator 依存関係がサポートされています。

olm.package-

このタイプは、特定の Operator バージョンの依存関係であることを意味します。依存関係情報には、パッケージ名とパッケージのバージョンを semver 形式で含める必要があります。たとえば、

0.5.2などの特定バージョンや>0.5.1などのバージョンの範囲を指定することができます。 olm.gvk- このタイプの場合、作成者は CSV の既存の CRD および API ベースの使用方法と同様に group/version/kind (GVK) 情報で依存関係を指定できます。これは、Operator の作成者がすべての依存関係、API または明示的なバージョンを同じ場所に配置できるようにするパスです。

olm.constraint- このタイプは、任意の Operator プロパティーに対するジェネリック制約を宣言します。

以下の例では、依存関係は Prometheus Operator および etcd CRD に指定されます。

dependencies.yaml ファイルの例

2.4.4.4. 一般的な制約

olm.constraint プロパティーは、特定のタイプの依存関係制約を宣言し、非制約プロパティーと制約プロパティーを区別します。その value フィールドは、制約メッセージの文字列表現を保持する failureMessage フィールドを含むオブジェクトです。このメッセージは、実行時に制約が満たされない場合に、ユーザーへの参考のコメントとして表示されます。

次のキーは、使用可能な制約タイプを示します。

gvk-

値と解釈が

olm.gvkタイプと同じタイプ package-

値と解釈が

olm.packageタイプと同じタイプ cel- 任意のバンドルプロパティーとクラスター情報に対して Operator Lifecycle Manager (OLM) リゾルバーによって実行時に評価される Common Expression Language (CEL) 式

all、any、not-

gvkやネストされた複合制約など、1 つ以上の具体的な制約を含む、論理積、論理和、否定の制約。

2.4.4.4.1. Common Expression Language (CEL) の制約

cel 制約型は、式言語として Common Expression Language (CEL) をサポートしています。cel 構造には、Operator が制約を満たしているかどうかを判断するために、実行時に Operator プロパティーに対して評価される CEL 式文字列を含む rule フィールドがあります。

cel 制約の例

type: olm.constraint

value:

failureMessage: 'require to have "certified"'

cel:

rule: 'properties.exists(p, p.type == "certified")'

type: olm.constraint

value:

failureMessage: 'require to have "certified"'

cel:

rule: 'properties.exists(p, p.type == "certified")'

CEL 構文は、AND や OR などの幅広い論理演算子をサポートします。その結果、単一の CEL 式は、これらの論理演算子で相互にリンクされる複数の条件に対して複数のルールを含めることができます。これらのルールは、バンドルまたは任意のソースからの複数の異なるプロパティーのデータセットに対して評価され、出力は、単一の制約内でこれらのルールのすべてを満たす単一のバンドルまたは Operator に対して解決されます。

複数のルールが指定された cel 制約の例

type: olm.constraint

value:

failureMessage: 'require to have "certified" and "stable" properties'

cel:

rule: 'properties.exists(p, p.type == "certified") && properties.exists(p, p.type == "stable")'

type: olm.constraint

value:

failureMessage: 'require to have "certified" and "stable" properties'

cel:

rule: 'properties.exists(p, p.type == "certified") && properties.exists(p, p.type == "stable")'2.4.4.4.2. 複合制約 (all, any, not)

複合制約タイプは、論理定義に従って評価されます。

以下は、2 つのパッケージと 1 つの GVK の接続制約 (all) の例です。つまり、インストールされたバンドルがすべての制約を満たす必要があります。

all 制約の例

以下は、同じ GVK の 3 つのバージョンの選言的制約 (any) の例です。つまり、インストールされたバンドルが少なくとも 1 つの制約を満たす必要があります。

any 制約の例

以下は、GVK の 1 つのバージョンの否定制約 (not) の例です。つまり、この結果セットのバンドルでは、この GVK を提供できません。

not の制約例

否定のセマンティクスは、not 制約のコンテキストで不明確であるように見える場合があります。つまり、この否定では、特定の GVK、あるバージョンのパッケージを含むソリューション、または結果セットからの子の複合制約を満たすソリューションを削除するように、リゾルバーに対して指示を出しています。

当然の結果として、最初に可能な依存関係のセットを選択せずに否定することは意味がないため、複合では not 制約は all または any 制約内でのみ使用する必要があります。

2.4.4.4.3. ネストされた複合制約

ネストされた複合制約 (少なくとも 1 つの子複合制約と 0 個以上の単純な制約を含む制約) は、前述の各制約タイプの手順に従って、下から上に評価されます。

以下は、接続詞の論理和の例で、one、the other、または both が制約を満たすことができます。

ネストされた複合制約の例

olm.constraint タイプの最大 raw サイズは 64KB に設定されており、リソース枯渇攻撃を制限しています。

2.4.4.5. 依存関係の設定

Operator の依存関係を同等に満たすオプションが多数ある場合があります。Operator Lifecycle Manager (OLM) の依存関係リゾルバーは、要求された Operator の要件に最も適したオプションを判別します。Operator の作成者またはユーザーとして、依存関係の解決が明確になるようにこれらの選択方法を理解することは重要です。

2.4.4.5.1. カタログの優先順位

Red Hat OpenShift Service on AWS クラスターでは、OLM がカタログソースを読み取り、どの Operator がインストール可能であるかを確認します。

CatalogSource オブジェクトの例

- 1

legacyまたはrestrictedの値を指定します。フィールドが設定されていない場合、デフォルト値はlegacyです。今後の Red Hat OpenShift Service on AWS リリースでは、デフォルト値がrestrictedになる予定です。注記restricted権限でカタログを実行できない場合は、このフィールドを手動でlegacyに設定することを推奨します。

CatalogSource オブジェクトには priority フィールドがあります。このフィールドは、依存関係のオプションを優先する方法を把握するためにリゾルバーによって使用されます。

カタログ設定を規定する 2 つのルールがあります。

- 優先順位の高いカタログにあるオプションは、優先順位の低いカタログのオプションよりも優先されます。

- 依存オブジェクトと同じカタログにあるオプションは他のカタログよりも優先されます。

2.4.4.5.2. チャネルの順序付け

カタログ内の Operator パッケージは、Red Hat OpenShift Service on AWS クラスターでユーザーがサブスクライブできる更新チャネルのコレクションです。チャネルは、マイナーリリース (1.2、1.3) またはリリース頻度 (stable、fast) に関する特定の更新ストリームを提供するために使用できます。

同じパッケージの Operators によって依存関係が満たされる可能性がありますが、その場合、異なるチャネルの Operators のバージョンによって満たされる可能性があります。たとえば、Operator のバージョン 1.2 は stable および fast チャネルの両方に存在する可能性があります。

それぞれのパッケージにはデフォルトのチャネルがあり、これは常にデフォルト以外のチャネルよりも優先されます。デフォルトチャネルのオプションが依存関係を満たさない場合には、オプションは、チャネル名の辞書式順序 (lexicographic order) で残りのチャネルから検討されます。

2.4.4.5.3. チャネル内での順序

ほとんどの場合、単一のチャネル内に依存関係を満たすオプションが複数あります。たとえば、1 つのパッケージおよびチャネルの Operators は同じセットの API を提供します。

ユーザーがサブスクリプションを作成すると、それらはどのチャネルから更新を受け取るかを示唆します。これにより、すぐにその 1 つのチャネルだけに検索が絞られます。ただし、チャネル内では、多くの Operators が依存関係を満たす可能性があります。

チャネル内では、更新グラフでより上位にある新規 Operators が優先されます。チャネルのヘッドが依存関係を満たす場合、これがまず試行されます。

2.4.4.5.4. その他の制約

OLM には、パッケージの依存関係で指定される制約のほかに、必要なユーザーの状態を表し、常にメンテナンスする必要のある依存関係の解決を適用するための追加の制約が含まれます。

2.4.4.5.4.1. サブスクリプションの制約

サブスクリプションの制約は、サブスクリプションを満たすことのできる Operators のセットをフィルターします。サブスクリプションは、依存関係リゾルバーに関するユーザー指定の制約です。それらは、クラスター上にない場合は新規 Operator をインストールすることを宣言するか、既存 Operator の更新された状態を維持することを宣言します。

2.4.4.5.4.2. パッケージの制約

namespace 内では、2 つの Operators が同じパッケージから取得されることはありません。

2.4.4.6. CRD のアップグレード

OLM は、単一のクラスターサービスバージョン (CSV) によって所有されている場合にはカスタムリソース定義 (CRD) をすぐにアップグレードします。CRD が複数の CSV によって所有されている場合、CRD は、以下の後方互換性の条件のすべてを満たす場合にアップグレードされます。

- 現行 CRD の既存の有効にされたバージョンすべてが新規 CRD に存在する。

- 検証が新規 CRD の検証スキーマに対して行われる場合、CRD の提供バージョンに関連付けられる既存インスタンスまたはカスタムリソースすべてが有効である。

2.4.4.7. 依存関係のベストプラクティス

依存関係を指定する際には、ベストプラクティスを考慮する必要があります。

- Operators の API または特定のバージョン範囲によって異なります。

-

Operators は API をいつでも追加または削除できます。Operators が必要とする API に

olm.gvk依存関係を常に指定できます。これの例外は、olm.package制約を代わりに指定する場合です。 - 最小バージョンの設定

API の変更に関する Kubernetes ドキュメントでは、Kubernetes 形式の Operators で許可される変更を説明しています。これらのバージョン管理規則により、Operator は API バージョンに後方互換性がある限り、API バージョンに影響を与えずに API を更新することができます。

Operator の依存関係の場合、依存関係の API バージョンを把握するだけでは、依存する Operator が確実に意図された通りに機能することを確認できないことを意味します。

以下に例を示します。

-

TestOperator v1.0.0 は、v1alpha1 API バージョンの

MyObjectリソースを提供します。 -

TestOperator v1.0.1 は新しいフィールド

spec.newfieldをMyObjectに追加しますが、v1alpha1 のままになります。

Operator では、

spec.newfieldをMyObjectリソースに書き込む機能が必要になる場合があります。olm.gvk制約のみでは、OLM で TestOperator v1.0.0 ではなく TestOperator v1.0.1 が必要であると判断することはできません。可能な場合には、API を提供する特定の Operator が事前に分かっている場合、最小値を設定するために追加の

olm.package制約を指定します。-

TestOperator v1.0.0 は、v1alpha1 API バージョンの

- 最大バージョンを省略するか、幅広いバージョンを許可します。

Operators は API サービスや CRD などのクラスタースコープのリソースを提供するため、依存関係に小規模な範囲を指定する Operator は、その依存関係の他のコンシューマーの更新に不要な制約を加える可能性があります。

可能な場合は、最大バージョンを設定しないでください。または、他の Operators との競合を防ぐために、幅広いセマンティクスの範囲を設定します。例:

>1.0.0 <2.0.0従来のパッケージマネージャーとは異なり、Operator の作成者は更新が OLM のチャネルで更新を安全に行われるように Operator を明示的にエンコードします。更新が既存のサブスクリプションで利用可能な場合、Operator の作成者がこれが以前のバージョンから更新できることを示唆していることが想定されます。依存関係の最大バージョンを設定すると、特定の上限で不必要な切り捨てが行われることにより、作成者の更新ストリームが上書きされます。

注記クラスター管理者は、Operator の作成者が設定した依存関係を上書きすることはできません。

ただし、回避する必要がある非互換性があることが分かっている場合は、最大バージョンを設定でき、およびこれを設定する必要があります。バージョン範囲の構文を使用すると、複数の特定のバージョンを省略できます (例:

> 1.0.0 !1.2.1)。

2.4.4.8. 依存関係に関する注意事項

依存関係を指定する際には、考慮すべき注意事項があります。

- 複合制約がない (AND)

現時点で、制約の間に AND 関係を指定する方法はありません。つまり、ある Operator が、所定の API を提供し、バージョン

>1.1.0を持つ別の Operator に依存するように指定することはできません。依存関係を指定すると、以下のようになります。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow OLM は EtcdCluster を提供する Operators とバージョン

>3.1.0を持つ Operators の 2 つの Operators で、上記の依存関係の例の条件を満たすことができる可能性があります。その場合や、または両方の制約を満たす Operator が選択されるかどうかは、選択できる可能性のあるオプションが参照される順序によって変わります。依存関係の設定および順序のオプションは十分に定義され、理にかなったものであると考えられますが、Operators は継続的に特定のメカニズムをベースとする必要があります。- namespace 間の互換性

- OLM は namespace スコープで依存関係の解決を実行します。ある namespace での Operator の更新が別の namespace の Operator の問題となる場合、更新のデッドロックが生じる可能性があります。

2.4.4.9. 依存関係解決のシナリオ例

以下の例で、プロバイダー は CRD または API サービスを "所有" する Operator です。

2.4.4.9.1. 例: 依存 API を非推奨にする

A および B は API (CRD):

- A のプロバイダーは B によって異なる。

- B のプロバイダーにはサブスクリプションがある。

- B のプロバイダーは C を提供するように更新するが、B を非推奨にする。

この結果は以下のようになります。

- B にはプロバイダーがなくなる。

- A は機能しなくなる。

これは OLM がアップグレードストラテジーで回避するケースです。

2.4.4.9.2. 例: バージョンのデッドロック

A および B は API である:

- A のプロバイダーは B を必要とする。

- B のプロバイダーは A を必要とする。

- A のプロバイダーは (A2 を提供し、B2 を必要とするように) 更新し、A を非推奨にする。

- B のプロバイダーは (B2 を提供し、A2 を必要とするように) 更新し、B を非推奨にする。

OLM が B を同時に更新せずに A を更新しようとする場合や、その逆の場合、OLM は、新しい互換性のあるセットが見つかったとしても Operators の新規バージョンに進むことができません。

これは OLM がアップグレードストラテジーで回避するもう 1 つのケースです。

2.4.5. Operator グループ

ここでは、Red Hat OpenShift Service on AWS における Operator Lifecycle Manager (OLM) での Operator グループの使用を概説します。

2.4.5.1. Operator グループについて

Operator グループ は、OperatorGroup リソースによって定義され、マルチテナント設定を OLM でインストールされた Operators に提供します。Operator グループは、そのメンバー Operators に必要な RBAC アクセスを生成するために使用するターゲット namespace を選択します。

ターゲット namespace のセットは、クラスターサービスバージョン (CSV) の olm.targetNamespaces アノテーションに保存されるコンマ区切りの文字列によって指定されます。このアノテーションは、メンバー Operator の CSV インスタンスに適用され、そのデプロイメントに反映されます。

2.4.5.2. Operator グループメンバーシップ

Operator は、以下の条件が true の場合に Operator グループの メンバー とみなされます。

- Operator の CSV が Operator グループと同じ namespace にある。

- Operator の CSV のインストールモードは Operator グループがターゲットに設定する namespace のセットをサポートする。

CSV のインストールモードは InstallModeType フィールドおよびブール値の Supported フィールドで構成されます。CSV の仕様には、4 つの固有の InstallModeTypes のインストールモードのセットを含めることができます。

| InstallModeType | 説明 |

|---|---|

|

| Operator は、独自の namespace を選択する Operator グループのメンバーにすることができます。 |

|

| Operator は 1 つの namespace を選択する Operator グループのメンバーにすることができます。 |

|

| Operator は複数の namespace を選択する Operator グループのメンバーにすることができます。 |

|

|

Operator はすべての namespace を選択する Operator グループのメンバーにすることができます (設定されるターゲット namespace は空の文字列 |

CSV の仕様が InstallModeType のエントリーを省略する場合、そのタイプは暗黙的にこれをサポートする既存エントリーによってサポートが示唆されない限り、サポートされないものとみなされます。

2.4.5.3. ターゲット namespace の選択

spec.targetNamespaces パラメーターを使用して Operator グループのターゲット namespace に名前を明示的に指定することができます。

または、spec.selector パラメーターでラベルセレクターを使用して namespace を指定することもできます。

spec.targetNamespaces で複数の namespace をリスト表示したり、spec.selector でラベルセレクターを使用したりすることは推奨されません。Operator グループの複数のターゲット namespace のサポートは今後のリリースで取り除かれる可能性があります。

spec.targetNamespaces と spec.selector の両方が定義されている場合、spec.selector は無視されます。または、spec.selector と spec.targetNamespaces の両方を省略し、global Operator グループを指定できます。これにより、すべての namespace が選択されます。

apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: my-group namespace: my-namespace

apiVersion: operators.coreos.com/v1

kind: OperatorGroup

metadata:

name: my-group

namespace: my-namespace

選択された namespace の解決済みのセットは Operator グループの status.namespaces パラメーターに表示されます。グローバル Operator グループの status.namespace には空の文字列 ("") が含まれます。これは、消費する Operator に対し、すべての namespace を監視するように示唆します。

2.4.5.4. Operator グループの CSV アノテーション

Operator グループのメンバー CSV には以下のアノテーションがあります。

| アノテーション | 説明 |

|---|---|

|

| Operator グループの名前が含まれます。 |

|

| Operator グループの namespace が含まれます。 |

|

| Operator グループのターゲット namespace 選択をリスト表示するコンマ区切りの文字列が含まれます。 |

olm.targetNamespaces 以外のすべてのアノテーションがコピーされた CSV と共に含まれます。olm.targetNamespaces アノテーションをコピーされた CSV で省略すると、テナント間のターゲット namespace の重複が回避されます。

2.4.5.5. 提供される API アノテーション

group/version/kind(GVK) は Kubernetes API の一意の識別子です。Operator グループによって提供される GVK に関する情報が olm.providedAPIs アノテーションに表示されます。アノテーションの値は、コンマで区切られた <kind>.<version>.<group> で構成される文字列です。Operator グループのすべてのアクティブメンバーの CSV によって提供される CRD および API サービスの GVK が含まれます。

PackageManifest リースを提供する単一のアクティブメンバー CSV を含む OperatorGroup オブジェクトの以下の例を確認してください。

2.4.5.6. ロールベースのアクセス制御

Operator グループの作成時に、3 つのクラスタールールが生成されます。クラスターロールが生成されると、各クラスターロールが一意になるように、ハッシュ値が自動的に末尾に付加されます。各 Operator グループには、次の表に示すように、ラベルに一致するように設定されたクラスターロールセレクターを持つ 1 つの集約ルールが含まれています。

| クラスターロール | 一致するラベル |

|---|---|

|

|

|

|

|

|

|

|

|

Operator グループのクラスターロールを使用してリソースにロールベースのアクセス制御 (RBAC) を割り当てるには、次のコマンドを実行して、クラスターロールの完全な名前とハッシュ値を取得します。

oc get clusterroles | grep <operatorgroup_name>

$ oc get clusterroles | grep <operatorgroup_name>ハッシュ値は Operator グループの作成時に生成されるため、クラスターロールの完全な名前を検索するには、先に Operator グループを作成する必要があります。

以下の RBAC リソースは、CSV が AllNamespaces インストールモードのあるすべての namespace を監視しており、理由が InterOperatorGroupOwnerConflict の失敗状態にない限り、CSV が Operator グループのアクティブメンバーになる際に生成されます。

- CRD からの各 API リソースのクラスターロール

- API サービスからの各 API リソースのクラスターロール

- 追加のロールおよびロールバインディング

| クラスターロール | 設定 |

|---|---|

|

|

集計ラベル:

|

|

|

集計ラベル:

|

|

|

集計ラベル:

|

|

|

Verbs on

集計ラベル:

|

| クラスターロール | 設定 |

|---|---|

|

|

集計ラベル:

|

|

|

集計ラベル:

|

|

|

集計ラベル:

|

追加のロールおよびロールバインディング

-

CSV が

*が含まれる 1 つのターゲット namespace を定義する場合、クラスターロールと対応するクラスターロールバインディングが CSV のpermissionsフィールドに定義されるパーミッションごとに生成されます。生成されたすべてのリソースにはolm.owner: <csv_name>およびolm.owner.namespace: <csv_namespace>ラベルが付与されます。 -

CSV が

*が含まれる 1 つのターゲット namespace を定義 しない 場合、olm.owner: <csv_name>およびolm.owner.namespace: <csv_namespace>ラベルの付いた Operator namespace にあるすべてのロールおよびロールバインディングがターゲット namespace にコピーされます。

2.4.5.7. コピーされる CSV

OLM は、それぞれの Operator グループのターゲット namespace の Operator グループのすべてのアクティブな CSV のコピーを作成します。コピーされる CSV の目的は、ユーザーに対して、特定の Operator が作成されるリソースを監視するように設定されたターゲット namespace を通知することにあります。

コピーされる CSV にはステータスの理由 Copied があり、それらのソース CSV のステータスに一致するように更新されます。olm.targetNamespaces アノテーションは、クラスター上でコピーされる CSV が作成される前に取られます。ターゲット namespace 選択を省略すると、テナント間のターゲット namespace の重複が回避されます。

コピーされる CSV はそれらのソース CSV が存在しなくなるか、それらのソース CSV が属する Operator グループが、コピーされた CSV の namespace をターゲットに設定しなくなると削除されます。

デフォルトでは、disableCopiedCSVs フィールドは無効になっています。disableCopiedCSVs フィールドを有効にすると、OLM はクラスター上の既存のコピーされた CSV を削除します。disableCopiedCSVs フィールドが無効になると、OLM はコピーされた CSV を再度追加します。

disableCopiedCSVsフィールドを無効にします。Copy to Clipboard Copied! Toggle word wrap Toggle overflow disableCopiedCSVsフィールドを有効にします。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.5.8. 静的 Operator グループ

Operator グループはその spec.staticProvidedAPIs フィールドが true に設定されると 静的 になります。その結果、OLM は Operator グループの olm.providedAPIs アノテーションを変更しません。つまり、これを事前に設定することができます。これは、ユーザーが Operator グループを使用して namespace のセットでリソースの競合を防ぐ必要がある場合で、それらのリソースの API を提供するアクティブなメンバーの CSV がない場合に役立ちます。

以下は、something.cool.io/cluster-monitoring: "true" アノテーションのあるすべての namespace の Prometheus リソースを保護する Operator グループの例です。

2.4.5.9. Operator グループの交差部分

2 つの Operator グループは、それらのターゲット namespace セットの交差部分が空のセットではなく、olm.providedAPIs アノテーションで定義されるそれらの指定 API セットの交差部分が空のセットではない場合に、交差部分のある指定 API があると見なされます。

これによって生じ得る問題として、交差部分のある指定 API を持つ複数の Operator グループは、一連の交差部分のある namespace で同じリソースに関して競合関係になる可能性があります。

交差ルールを確認すると、Operator グループの namespace は常に選択されたターゲット namespace の一部として組み込まれます。

2.4.5.9.1. 交差のルール

アクティブメンバーの CSV が同期する際はいつでも、OLM はクラスターで、CSV の Operator グループとそれ以外のすべての間での交差部分のある指定 API のセットをクエリーします。その後、OLM はそのセットが空のセットであるかどうかを確認します。

trueであり、CSV の指定 API が Operator グループのサブセットである場合:- 移行を継続します。

trueであり、CSV の指定 API が Operator グループのサブセット ではない 場合:Operator グループが静的である場合:

- CSV に属するすべてのデプロイメントをクリーンアップします。

-

ステータスの理由

CannotModifyStaticOperatorGroupProvidedAPIsのある失敗状態に CSV を移行します。

Operator グループが静的 ではない 場合:

-

Operator グループの

olm.providedAPIsアノテーションを、それ自体と CSV の指定 API の集合に置き換えます。

-

Operator グループの

falseであり、CSV の指定 API が Operator グループのサブセット ではない 場合:- CSV に属するすべてのデプロイメントをクリーンアップします。

-

ステータスの理由

InterOperatorGroupOwnerConflictのある失敗状態に CSV を移行します。

falseであり、CSV の指定 API が Operator グループのサブセットである場合:Operator グループが静的である場合:

- CSV に属するすべてのデプロイメントをクリーンアップします。

-

ステータスの理由

CannotModifyStaticOperatorGroupProvidedAPIsのある失敗状態に CSV を移行します。

Operator グループが静的 ではない 場合:

-

Operator グループの

olm.providedAPIsアノテーションを、それ自体と CSV の指定 API 間の差異部分に置き換えます。

-

Operator グループの

Operator グループによって生じる失敗状態は非終了状態です。

以下のアクションは、Operator グループが同期するたびに実行されます。

- アクティブメンバーの CSV の指定 API のセットは、クラスターから計算されます。コピーされた CSV は無視されることに注意してください。

-

クラスターセットは

olm.providedAPIsと比較され、olm.providedAPIsに追加の API が含まれる場合は、それらの API がプルーニングされます。 - すべての namespace で同じ API を提供するすべての CSV は再びキューに入れられます。これにより、交差部分のあるグループ間の競合する CSV に対して、それらの競合が競合する CSV のサイズ変更または削除のいずれかによって解決されている可能性があることが通知されます。

2.4.5.10. マルチテナント Operator 管理の制限事項

Red Hat OpenShift Service on AWS では、同じクラスターに異なる Operator のバージョンを同時にインストールした場合、サポートが限定的になります。Operator Lifecycle Manager (OLM) は、Operator を異なる namespace に複数回インストールします。その 1 つの制約として、Operator の API バージョンは同じである必要があります。

Operators は、Kubernetes のグローバルリソースである CustomResourceDefinition オブジェクト (CRD) を使用するため、コントロールプレーンの拡張機能です。多くの場合、Operator の異なるメジャーバージョンには互換性のない CRD があります。これにより、クラスター上の異なる namespace に同時にインストールするのに互換性がなくなります。

すべてのテナントまたは namespace がクラスターの同じコントロールプレーンを共有します。したがって、マルチテナントクラスター内のテナントはグローバル CRD も共有するため、同じクラスターで同じ Operator の異なるインスタンスを並行して使用できるシナリオが制限されます。

サポートされているシナリオは次のとおりです。

- まったく同じ CRD 定義を提供する異なるバージョンの Operators (バージョン管理された CRD の場合は、まったく同じバージョンのセット)

- CRD を同梱しておらず、代わりにソフトウェアカタログ内の別のバンドルで CRD を提供している異なるバージョンの Operator

他のすべてのシナリオはサポートされていません。これは、異なる Operator バージョンからの複数の競合または重複する CRD が同じクラスター上で調整される場合、クラスターデータの整合性が保証されないためです。

2.4.5.11. Operator グループのトラブルシューティング

2.4.5.11.1. メンバーシップ

インストールプランの namespace には、Operator グループを 1 つだけ含める必要があります。namespace でクラスターサービスバージョン (CSV) を生成しようとすると、インストールプランでは、以下のシナリオの Operator グループが無効であると見なされます。

- インストールプランの namespace に Operator グループが存在しない。

- インストールプランの namespace に複数の Operator グループが存在する。

- Operator グループに、正しくないサービスアカウント名または存在しないサービスアカウント名が指定されている。

インストールプランで無効な Operator グループが検出された場合には、CSV は生成されず、

InstallPlanリソースは関連するメッセージを出力して、インストールを続行します。たとえば、複数の Operator グループが同じ namespace に存在する場合に以下のメッセージが表示されます。attenuated service account query failed - more than one operator group(s) are managing this namespace count=2

attenuated service account query failed - more than one operator group(s) are managing this namespace count=2Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここでは、

count=は、namespace 内の Operator グループの数を指します。-

CSV のインストールモードがその namespace で Operator グループのターゲット namespace 選択をサポートしない場合、CSV は

UnsupportedOperatorGroupの理由で失敗状態に切り替わります。この理由で失敗した状態にある CSV は、Operator グループのターゲット namespace の選択がサポートされる設定に変更されるか、CSV のインストールモードがターゲット namespace 選択をサポートするように変更される場合に、保留状態に切り替わります。

2.4.6. マルチテナント対応と Operator のコロケーション

このガイドでは、Operator Lifecycle Manager (OLM) のマルチテナント対応と Operator のコロケーションを説明します。

2.4.6.1. namespace 内での Operators コロケーション

Operator Lifecycle Manager (OLM) は、同じ namespace にインストールされている OLM 管理 Operators を処理します。つまり、それらの Subscription リソースは、関連する Operators として同じ namespace に配置されます。それらが実際には関連していなくても、いずれかが更新されると、OLM はバージョンや更新ポリシーなどの状態を考慮します。

このデフォルトの動作は、次の 2 つの方法で現れます。

-

保留中の更新の

InstallPlanリソースには、同じ namespace にある他のすべての Operators のClusterServiceVersion(CSV) リソースが含まれます。 - 同じ namespace 内のすべての Operators は、同じ更新ポリシーを共有します。たとえば、1 つの Operator が手動更新に設定されている場合は、他のすべての Operators の更新ポリシーも手動に設定されます。

これらのシナリオは、次の問題につながる可能性があります。

- 更新された Operator だけでなく、より多くのリソースが定義されているため、Operator 更新のインストール計画を推論するのは難しくなります。

- namespace 内の一部の Operator を自動で更新し、他の Operator を手動で更新するという、多くのクラスター管理者が求めていることが不可能になります。

通常、これらの問題が明らかになるのは、Red Hat OpenShift Service on AWS を使用して Operator をインストールするときに、デフォルトの動作により、All namespaces インストールモードをサポートする Operator が、デフォルトの openshift-operators グローバル namespace にインストールされるためです。

dedicated-admin ロールを持つ管理者は、次のワークフローを使用して、このデフォルトの動作を手動で回避できます。

- Operator をインストールするためのプロジェクトを作成します。

- すべての namespace を監視する Operator グループである、カスタム グローバル Operator グループ を作成します。この Operator グループを作成した namespace に関連付けることで、インストール namespace がグローバル namespace になり、そこにインストールされた Operators がすべての namespace で使用できるようになります。

- 必要な Operator をインストール namespace にインストールします。

Operator に依存関係がある場合、依存関係は事前に作成された namespace に自動的にインストールされます。その結果、依存関係 Operators が同じ更新ポリシーと共有インストールプランを持つことが有効になります。詳細な手順は、「カスタム namespace へのグローバル Operators のインストール」を参照してください。

2.4.7. Operator 条件

以下では、Operator Lifecycle Manager (OLM) による Operator 条件の使用方法を説明します。

2.4.7.1. Operator 条件について

Operator のライフサイクル管理のロールの一部として、Operator Lifecycle Manager (OLM) は、Operator を定義する Kubernetes リソースの状態から Operator の状態を推測します。このアプローチでは、Operator が特定の状態にあることをある程度保証しますが、推測できない情報を Operator が OLM と通信して提供する必要がある場合も多々あります。続いて、OLM がこの情報を使用して、Operator のライフサイクルをより適切に管理することができます。

OLM は、Operators が OLM に条件を通信できる OperatorCondition というカスタムリソース定義 (CRD) を提供します。OperatorCondition リソースの Spec.Conditions 配列にある場合に、OLM による Operator の管理に影響するサポートされる条件のセットがあります。

デフォルトでは、Spec.Conditions 配列は、ユーザーによって追加されるか、カスタム Operator ロジックの結果として追加されるまで、OperatorCondition オブジェクトに存在しません。

2.4.7.2. サポートされる条件

Operator Lifecycle Manager (OLM) は、以下の Operator 条件をサポートします。

2.4.7.2.1. アップグレード可能な条件

Upgradeable Operator 条件は、既存のクラスターサービスバージョン (CSV) が、新規の CSV バージョンに置き換えられることを阻止します。この条件は、以下の場合に役に立ちます。

- Operator が重要なプロセスを開始するところで、プロセスが完了するまでアップグレードしてはいけない場合

- Operator が、Operator のアップグレードの準備ができる前に完了する必要のあるカスタムリソース (CR) の移行を実行している場合

Upgradeable Operator の条件を False 値に設定しても、Pod の中断は回避できません。Pod が中断されないようにする必要がある場合は、「追加リソース」セクションの「Pod 中断バジェットを使用して稼働させなければならない Pod の数を指定する」と「正常な終了」を参照してください。

Upgradeable Operator 条件の例

2.4.8. Operator Lifecycle Manager メトリクス

2.4.8.1. 公開されるメトリクス

Operator Lifecycle Manager (OLM) は、Prometheus ベースの Red Hat OpenShift Service on AWS クラスターモニタリングスタックで使用される特定の OLM 固有のリソースを公開します。

| 名前 | 説明 |

|---|---|

|

| カタログソースの数。 |

|

|

カタログソースの状態。値 |

|

|

クラスターサービスバージョン (CSV) を調整する際に、(インストールされていない場合など) CSV バージョンが |

|

| 正常に登録された CSV の数。 |

|

|

CSV を調整する際に、CSV バージョンが |

|

| CSV アップグレードの単調 (monotonic) カウント。 |

|

| インストール計画の数。 |

|

| インストール計画に含まれる非推奨のリソースなど、リソースによって生成される警告の個数。 |

|

| 依存関係解決の試行期間。 |

|

| サブスクリプションの数。 |

|

|

サブスクリプション同期の単調 (monotonic) カウント。 |

2.4.9. Operator Lifecycle Manager での Webhook の管理

Webhook により、リソースがオブジェクトストアに保存され、Operator コントローラーによって処理される前に、Operator の作成者はリソースのインターセプト、変更、許可、および拒否を実行することができます。Operator Lifecycle Manager (OLM) は、Operator と共に提供される際にこれらの Webhook のライフサイクルを管理できます。

2.5. ソフトウェアカタログの概要

2.5.1. ソフトウェアカタログについて

ソフトウェアカタログ は Red Hat OpenShift Service on AWS の Web コンソールインターフェイスです。クラスター管理者はこれを使用して Operator を検出し、インストールします。1 回のクリックで、Operator をクラスター外のソースからプルし、クラスター上でインストールおよびサブスクライブして、エンジニアリングチームが Operator Lifecycle Manager (OLM) を使用してデプロイメント環境全体で製品をセルフサービスで管理される状態にすることができます。

クラスター管理者は、以下のカテゴリーにグループ化されたカタログから選択することができます。

| カテゴリー | 説明 |

|---|---|

| Red Hat Operators | Red Hat によってパッケージ化され、出荷される Red Hat 製品。Red Hat によってサポートされます。 |

| Certified Operators | 大手独立系ソフトウェアベンダー (ISV) の製品。Red Hat は ISV とのパートナーシップにより、パッケージ化および出荷を行います。ISV によってサポートされます。 |

| Community Operators | redhat-openshift-ecosystem/community-operators-prod/operators GitHub リポジトリーで関連する担当者によって保守されているオプションで表示可能なソフトウェア。正式なサポートはありません。 |

| Custom Operators | 各自でクラスターに追加する Operator。カスタム Operator を追加していない場合、Web コンソールソフトウェアカタログに Custom カテゴリーは表示されません。 |

ソフトウェアカタログ内の Operator は、OLM 上で実行できるようにパッケージ化されています。これには、Operator のインストールおよびセキュアな実行に必要なすべての CRD、RBAC ルール、デプロイメント、およびコンテナーイメージが含まれるクラスターサービスバージョン (CSV) という YAML ファイルが含まれます。また、機能の詳細やサポートされる Kubernetes バージョンなどのユーザーに表示される情報も含まれます。

2.5.2. ソフトウェアカタログのアーキテクチャー

ソフトウェアカタログ UI コンポーネントは、デフォルトで、Red Hat OpenShift Service on AWS の openshift-marketplace namespace で Marketplace Operator によって実行されます。

2.5.2.1. OperatorHub カスタムリソース

Marketplace Operator は、ソフトウェアカタログで提供されるデフォルトの CatalogSource オブジェクトを管理する、cluster という名前の OperatorHub カスタムリソース (CR) を管理します。

2.6. Red Hat が提供する Operator カタログ

Red Hat は、Red Hat OpenShift Service on AWS にデフォルトで含まれる複数の Operator カタログを提供します。

Red Hat OpenShift Service on AWS 4.11 の時点で、デフォルトの Red Hat が提供する Operator カタログは、ファイルベースのカタログ形式でリリースされます。Red Hat OpenShift Service on AWS 4.6 から 4.10 までのデフォルトの Red Hat が提供する Operator カタログは、非推奨の SQLite データベース形式でリリースされました。

opm サブコマンド、フラグ、および SQLite データベース形式に関連する機能も非推奨となり、今後のリリースで削除されます。機能は引き続きサポートされており、非推奨の SQLite データベース形式を使用するカタログに使用する必要があります。

opm index prune などの SQLite データベース形式を使用する opm サブコマンドおよびフラグの多くは、ファイルベースのカタログ形式では機能しません。ファイルベースのカタログを使用する方法の詳細は、カスタムカタログの管理 および Operator Framework パッケージ形式 を参照してください。

2.6.1. Operator カタログについて

Operator カタログは、Operator Lifecycle Manager (OLM) がクエリーを行い、Operators およびそれらの依存関係をクラスターで検出し、インストールできるメタデータのリポジトリーです。OLM は最新バージョンのカタログから Operators を常にインストールします。

Operator Bundle Format に基づくインデックスイメージは、カタログのコンテナー化されたスナップショットです。これは、Operator マニフェストコンテンツのセットへのポインターのデータベースが含まれるイミュータブルなアーティファクトです。カタログはインデックスイメージを参照し、クラスター上の OLM のコンテンツを調達できます。

カタログが更新されると、Operators の最新バージョンが変更され、それ以前のバージョンが削除または変更される可能性があります。また、制限されたネットワーク環境の Red Hat OpenShift Service on AWS クラスター上で OLM が実行されている場合、インターネットからカタログに直接アクセスして最新のコンテンツをプルすることはできません。

クラスター管理者は、Red Hat が提供するカタログをベースとして使用して、またはゼロから独自のカスタムインデックスイメージを作成できます。これを使用して、クラスターのカタログコンテンツを調達できます。独自のインデックスイメージの作成および更新により、クラスターで利用可能な Operators のセットをカスタマイズする方法が提供され、また前述のネットワークが制限された環境の問題を回避することができます。

Kubernetes は定期的に特定の API を非推奨とし、後続のリリースで削除します。そのため、Red Hat OpenShift Service on AWS のバージョンで、API が削除された Kubernetes バージョンが採用されると、Operator がその API を使用できなくなります。

Operator のレガシー パッケージマニフェスト形式 (レガシー形式を使用していたカスタムカタログを含む) のサポートは、Red Hat OpenShift Service on AWS 4.8 以降で削除されました。

カスタムカタログイメージを作成する場合、Red Hat OpenShift Service on AWS 4 の以前のバージョンでは oc adm catalog build コマンドを使用する必要がありました。このコマンドはいくつかのリリースで非推奨となり、現在は削除されています。Red Hat OpenShift Service on AWS 4.6 以降、Red Hat 提供のインデックスイメージが利用可能になったため、カタログ作成者は opm index コマンドを使用してインデックスイメージを管理する必要があります。

2.6.2. Red Hat が提供する Operator カタログについて

Red Hat が提供するカタログソースは、デフォルトで openshift-marketplace namespace にインストールされます。これにより、すべての namespace でクラスター全体でカタログを利用できるようになります。

以下の Operator カタログは Red Hat によって提供されます。

| Catalog | インデックスイメージ | 説明 |

|---|---|---|

|

|

| Red Hat によってパッケージ化され、出荷される Red Hat 製品。Red Hat によってサポートされます。 |

|

|

| 大手独立系ソフトウェアベンダー (ISV) の製品。Red Hat は ISV とのパートナーシップにより、パッケージ化および出荷を行います。ISV によってサポートされます。 |

|

|

| redhat-openshift-ecosystem/community-operators-prod/operators GitHub リポジトリーで、関連する担当者によって保守されているソフトウェア。正式なサポートはありません。 |

クラスターのアップグレード時に、Red Hat が提供するデフォルトのカタログソースのインデックスイメージのタグは、Operator Lifecycle Manager (OLM) が最新版のカタログをプルするように、Cluster Version Operator (CVO) により自動更新されます。たとえば、Red Hat OpenShift Service on AWS 4.8 から 4.9 へのアップグレード時に、redhat-operators カタログの CatalogSource オブジェクトの spec.image フィールドは次のように更新されます。

registry.redhat.io/redhat/redhat-operator-index:v4.8

registry.redhat.io/redhat/redhat-operator-index:v4.8更新後は次のようになります。

registry.redhat.io/redhat/redhat-operator-index:v4.9

registry.redhat.io/redhat/redhat-operator-index:v4.92.7. マルチテナントクラスター内の Operators

Operator Lifecycle Manager (OLM) のデフォルトの動作は、Operator のインストール時に簡素化することを目的としています。ただし、この動作は、特にマルチテナントクラスターでは柔軟性に欠ける場合があります。Red Hat OpenShift Service on AWS クラスター上の複数のテナントが Operator を使用するには、OLM のデフォルトの動作では、管理者が Operator を All namespaces モードでインストールする必要がありますが、これは最小特権の原則に違反すると考えられます。

以下のシナリオを考慮して、環境と要件に最適な Operator インストールワークフローを決定してください。

2.7.1. デフォルトの Operator インストールモードと動作

管理者として Web コンソールを使用して Operators をインストールする場合、通常、Operators の機能に応じて、インストールモードに 2 つの選択肢があります。

- 単一の namespace

- 選択した単一の namespace に Operator をインストールし、Operator が要求するすべての権限をその namespace で使用できるようにします。

- すべての namespace

-

デフォルトの

openshift-operatorsnamespace で Operator をインストールし、クラスターのすべての namespace を監視し、Operator をこれらの namespace に対して利用可能にします。Operator が要求するすべてのアクセス許可をすべての namespace で使用できるようにします。場合によっては、Operator の作成者はメタデータを定義して、その Operator が提案する namespace の 2 番目のオプションをユーザーに提供できます。

この選択は、影響を受ける namespace のユーザーが、namespace でのロールに応じて、所有するカスタムリソース (CR) を活用できる Operators API にアクセスできることも意味します。

-

namespace-adminおよびnamespace-editロールは、Operator API の読み取り/書き込みが可能です。つまり、Operator API を使用できます。 -

namespace-viewロールは、その Operator の CR オブジェクトを読み取ることができます。

Single namespace モードの場合、Operator 自体が選択した namespace にインストールされるため、その Pod とサービスアカウントもそこに配置されます。All namespaces モードの場合、Operator の権限はすべて自動的にクラスターロールに昇格されます。つまり、Operator はすべての namespace でこれらの権限を持ちます。

2.7.2. マルチテナントクラスターの推奨ソリューション

Multinamespace インストールモードは存在しますが、サポートされている Operators はほとんどありません。標準 All namespaces と Single namespace インストールモードの中間的なソリューションとして、次のワークフローを使用して、テナントごとに 1 つずつ、同じ Operator の複数のインスタンスをインストールできます。

- テナントの namespace とは別のテナント Operator の namespace を作成します。これは、プロジェクトを作成することで実行できます。

- テナントの namespace のみを対象とするテナント Operator の Operator グループを作成します。

- テナント Operator namespace に Operator をインストールします。

その結果、Operator はテナントの Operator namespace に存在し、テナントの namespace を監視しますが、Operator の Pod もそのサービスアカウントも、テナントによって表示または使用できません。

このソリューションは、より優れたテナント分離、リソースの使用を犠牲にした最小特権の原則、および制約が確実に満たされるようにするための追加のオーケストレーションを提供します。詳細な手順は、「マルチテナントクラスター用の Operator の複数インスタンスの準備」を参照してください。

制限および考慮事項

このソリューションは、次の制約が満たされている場合にのみ機能します。

- 同じ Operator のすべてのインスタンスは、同じバージョンである必要があります。

- Operator は、他の Operators に依存することはできません。

- Operator は CRD 変換 Webhook を出荷できません。

同じクラスターで同じ Operator の異なるバージョンを使用することはできません。最終的に、Operator の別のインスタンスのインストールは、以下の条件を満たす場合にブロックされます。

- インスタンスは Operator の最新バージョンではありません。

- インスタンスは、クラスターですでに使用されている新しいリビジョンに含まれる情報またはバージョンを欠いている CRD の古いリビジョンを出荷します。

2.7.3. Operator のコロケーションと Operator グループ

Operator Lifecycle Manager (OLM) は、同じ namespace にインストールされている OLM 管理 Operators を処理します。つまり、それらの Subscription リソースは、関連する Operators として同じ namespace に配置されます。それらが実際には関連していなくても、いずれかが更新されると、OLM はバージョンや更新ポリシーなどの状態を考慮します。

Operator のコロケーションと Operator グループの効果的な使用の詳細は、Operator Lifecycle Manager (OLM) → マルチテナント対応と Operator のコロケーション を参照してください。

2.8. CRD

2.8.1. カスタムリソース定義からのリソースの管理

以下では、開発者がカスタムリソース定義 (CRD) にあるカスタムリソース (CR) をどのように管理できるかを説明します。

2.8.1.1. カスタムリソース定義

Kubernetes API では、リソース は特定の種類の API オブジェクトのコレクションを保管するエンドポイントです。たとえば、ビルトインされた Pods リソースには、Pod オブジェクトのコレクションが含まれます。

カスタムリソース定義 (CRD) オブジェクトは、クラスター内に新規の固有オブジェクト kind を定義し、Kubernetes API サーバーにそのライフサイクル全体を処理させます。

カスタムリソース (CR) オブジェクトは、クラスター管理者によってクラスターに追加された CRD から作成され、すべてのクラスターユーザーが新規リソースタイプをプロジェクトに追加できるようにします。

Operators はとりわけ CRD を必要な RBAC ポリシーおよび他のソフトウェア固有のロジックでパッケージ化することで CRD を利用します。

2.8.1.2. ファイルからのカスタムリソースの作成

カスタムリソース定義 (CRD) がクラスターに追加された後に、クラスターリソース (CR) は CR 仕様を使用するファイルを使って CLI で作成できます。

手順

CR の YAML ファイルを作成します。以下の定義例では、

cronSpecとimageのカスタムフィールドがKind: CronTabの CR に設定されます。このKindは、CRD オブジェクトのspec.kindフィールドから取得されます。CR の YAML ファイルサンプル

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルの作成後に、オブジェクトを作成します。

oc create -f <file_name>.yaml

$ oc create -f <file_name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.8.1.3. カスタムリソースの検査

CLI を使用してクラスターに存在するカスタムリソース (CR) オブジェクトを検査できます。

前提条件

- CR オブジェクトがアクセスできる namespace にあること。

手順

CR の特定の kind に関する情報を取得するには、以下を実行します。

oc get <kind>

$ oc get <kind>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

oc get crontab

$ oc get crontabCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME KIND my-new-cron-object CronTab.v1.stable.example.com

NAME KIND my-new-cron-object CronTab.v1.stable.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow リソース名では大文字と小文字が区別されず、CRD で定義される単数形または複数形のいずれか、および任意の短縮名を指定できます。以下に例を示します。

oc get crontabs

$ oc get crontabsCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc get crontab

$ oc get crontabCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc get ct

$ oc get ctCopy to Clipboard Copied! Toggle word wrap Toggle overflow CR の未加工の YAML データを確認することもできます。

oc get <kind> -o yaml

$ oc get <kind> -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

oc get ct -o yaml

$ oc get ct -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第3章 ユーザータスク

3.1. インストールされた Operator からのアプリケーションの作成

以下では、開発者を対象に、Red Hat OpenShift Service on AWS Web コンソールを使用して、インストールされた Operator からアプリケーションを作成する例を示します。

3.1.1. Operator を使用した etcd クラスターの作成

この手順では、Operator Lifecycle Manager (OLM) で管理される etcd Operator を使用した新規 etcd クラスターの作成を説明します。

前提条件

- Red Hat OpenShift Service on AWS クラスターへのアクセス。

- 管理者によってクラスター全体に etcd Operator がすでにインストールされている。

手順

-

この手順を実行するために Red Hat OpenShift Service on AWS Web コンソールで新規プロジェクトを作成します。この例では、

my-etcdというプロジェクトを使用します。 Ecosystem → Installed Operators ページに移動します。このページには、dedicated-admin によってクラスターにインストールされた使用可能な Operators が、クラスターサービスバージョン (CSV) のリストの形で表示されます。CSV は Operator によって提供されるソフトウェアを起動し、管理するために使用されます。

ヒント以下を使用して、CLI でこのリストを取得できます。

oc get csv

$ oc get csvCopy to Clipboard Copied! Toggle word wrap Toggle overflow Installed Operators ページで、etcd Operator をクリックして詳細情報および選択可能なアクションを表示します。

Provided APIs に表示されているように、この Operator は 3 つの新規リソースタイプを利用可能にします。これには、etcd クラスター (

EtcdClusterリソース) のタイプが含まれます。これらのオブジェクトは、DeploymentまたはReplicaSetなどの組み込み済みのネイティブ Kubernetes オブジェクトと同様に機能しますが、これらには etcd を管理するための固有のロジックが含まれます。新規 etcd クラスターを作成します。

- etcd Cluster API ボックスで、Create instance をクリックします。

-

次のページでは、

EtcdClusterオブジェクト (クラスターのサイズなど) のテンプレートを起動する最小条件を変更できます。ここでは Create をクリックして確定します。これにより、Operator がトリガーされ、Pod、サービス、および新規 etcd クラスターの他のコンポーネントが起動します。

example etcd クラスター、Resources タブの順にクリックし、Operator が自動的に作成および設定した多数のリソースが含まれていることを確認します。

Kubernetes サービスが作成され、プロジェクトの他の Pod からデータベースにアクセスできることを確認します。

所定プロジェクトで

editロールを持つすべてのユーザーは、クラウドサービスのようにセルフサービス方式でプロジェクトにすでに作成されている Operators によって管理されるアプリケーションのインスタンス (この例では etcd クラスター) を作成し、管理し、削除することができます。この機能を持つ追加のユーザーを有効にする必要がある場合、プロジェクト管理者は以下のコマンドを使用してこのロールを追加できます。oc policy add-role-to-user edit <user> -n <target_project>

$ oc policy add-role-to-user edit <user> -n <target_project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

これで、etcd クラスターは Pod が正常でなくなったり、クラスターのノード間で移行する際の障害に対応し、データのリバランスを行います。最も重要なことは、適切なアクセス権を持つ dedicated-admin または開発者が、アプリケーションでデータベースを簡単に使用できるようになった点です。

第4章 管理者タスク

4.1. Operator のクラスターへの追加

dedicated-admin ロールを持つ管理者は、Operator Lifecycle Manager (OLM) を使用して、OLM ベースの Operator を Red Hat OpenShift Service on AWS クラスターにインストールできます。

OLM が同一 namespace に配置されたインストール済み Operators の更新を処理する方法や、カスタムグローバル Operator グループで Operators をインストールする別の方法は、マルチテナント対応と Operator のコロケーション を参照してください。

4.1.1. ソフトウェアカタログからの Operator のインストールについて

ソフトウェアカタログは、Operator を検索するためのユーザーインターフェイスです。これは、クラスター上で Operator をインストールして管理する Operator Lifecycle Manager (OLM) と連携して動作します。

dedicated-admin は、Red Hat OpenShift Service on AWS Web コンソールまたは CLI を使用してソフトウェアカタログから Operator をインストールできます。Operator を 1 つまたは複数の namespace にサブスクライブし、Operator をクラスター上で開発者が使用できるようにできます。

インストール時に、Operator の以下の初期設定を判別する必要があります。

- インストールモード

- All namespaces on the cluster (default) を選択して Operator をすべての namespace にインストールするか、(利用可能な場合は) 個別の namespace を選択し、選択された namespace のみに Operator をインストールします。この例では、All namespaces… を選択し、Operator をすべてのユーザーおよびプロジェクトで利用可能にします。

- 更新チャネル

- Operator が複数のチャネルで利用可能な場合、サブスクライブするチャネルを選択できます。たとえば、(利用可能な場合に) stable チャネルからデプロイするには、これをリストから選択します。

- 承認ストラテジー

自動 (Automatic) または手動 (Manual) のいずれかの更新を選択します。

インストールされた Operator に自動更新を選択する場合、Operator の新規バージョンが選択されたチャネルで利用可能になると、Operator Lifecycle Manager (OLM) は人の介入なしに、Operator の実行中のインスタンスを自動的にアップグレードします。

手動更新を選択した場合、新しいバージョンの Operator が利用可能になると、OLM によって更新要求が作成されます。その後、

dedicated-adminとして、その更新リクエストを手動で承認して、Operator を新しいバージョンに更新する必要があります。

4.1.2. Web コンソールを使用してソフトウェアカタログからインストールする

Red Hat OpenShift Service on AWS Web コンソールを使用して、ソフトウェアカタログから Operator をインストールしてサブスクライブできます。

前提条件

- 以下のアカウントを使用して Red Hat OpenShift Service on AWS クラスターにアクセスしておく。

手順

- Web コンソールで、Ecosystem → Software Catalog ページに移動します。

スクロールするか、キーワードを Filter by keyword ボックスに入力し、必要な Operator を見つけます。たとえば、Advanced Cluster Management for Kubernetes Operator を検索するには

advancedを入力します。また、インフラストラクチャー機能 でオプションをフィルターすることもできます。たとえば、非接続環境 (ネットワークが制限された環境ともしても知られる) で機能する Operators を表示するには、Disconnected を選択します。

Operator を選択して、追加情報を表示します。

注記コミュニティー Operator を選択すると、Red Hat がコミュニティー Operator を認定していないことを警告します。続行する前に警告を確認する必要があります。

- Operator の情報を確認してから、Install をクリックします。

Install Operator ページで、Operator のインストールを設定します。

特定のバージョンの Operator をインストールする場合は、リストから Update channel と Version を選択します。Operator のすべてのチャネルから Operator のさまざまなバージョンを参照し、そのチャネルとバージョンのメタデータを表示して、インストールする正確なバージョンを選択できます。

注記バージョン選択のデフォルトは、選択したチャネルの最新バージョンです。チャネルの最新バージョンが選択されている場合は、自動 承認戦略がデフォルトで有効になります。それ以外の場合、選択したチャネルの最新バージョンをインストールしない場合は、手動 による承認が必要です。

手動 承認を使用して Operator をインストールすると、namespace 内にインストールされたすべての Operators が 手動 承認戦略で機能し、すべての Operators が一緒に更新されます。Operators を個別に更新する場合は、Operators を別の namespace にインストールします。

Operator のインストールモードを確認します。

-

All namespaces on the cluster (default) は、デフォルトの