インスタンス&イメージガイド

インスタンスとイメージの管理

概要

前書き

Red Hat OpenStack Platform は、Red Hat Enterprise Linux をベースとして、プライベートまたはパブリックの Infrastructure-as-a-Service (IaaS) クラウドを構築するための基盤を提供します。これにより、スケーラビリティーが極めて高く、耐障害性に優れたプラットフォームをクラウド対応のワークロード開発にご利用いただくことができます。

本ガイドでは、イメージとインスタンスの作成/管理手順について説明します。また、Red Hat OpenStack Platform のインスタンス用ストレージの設定手順も記載しています。

OpenStack Dashboard またはコマンドラインクライアントを使用してクラウドの管理を行うことができます。大半の手順は、これらのいずれかの方法を使用することができますが、一部の高度な手順はコマンドラインのみで実行可能となっています。本ガイドでは、可能な場合には Dashboard を使用する手順を記載しています。

Red Hat OpenStack Platform の全ドキュメントスイートは Red Hat OpenStack Platform の製品ドキュメント で参照してください。

第1章 Image サービス

本章では、Red Hat OpenStack Platform でイメージとストレージを管理するための手順を説明します。

仮想マシンのイメージとは、起動可能なオペレーティングシステムがインストールされた仮想ディスクを含むファイルです。仮想マシンのイメージは、複数の形式をサポートしています。以下は、Red Hat OpenStack Platform で利用可能な形式です。

-

RAW: 非構造化のディスクイメージ形式 -

QCOW2: QEMU エミュレーターでサポートされているディスク形式。この形式には、QEMU 1.1 以降が必要な QCOW2v3 (QCOW3 と呼ばれる場合があります) が含まれます。 -

ISO: ディスク上のデータをセクター単位でコピーし、バイナリーファイルに格納した形式 -

AKI: Amazon Kernel Image -

AMI: Amazon Machine Image -

ARI: Amazon RAMDisk Image -

VDI: VirtualBox の仮想マシンモニターおよび QEMU エミュレーターでサポートされているディスク形式 -

VHD: VMware、VirtualBox などの仮想マシンモニターで使用されている一般的なディスク形式 -

VMDK: 数多くの一般的な仮想マシンモニターでサポートされているディスク形式

通常、仮想マシンイメージの形式に ISO は考慮されませんが、ISO にはオペレーティングシステムがインストール済みのブート可能なファイルシステムが含まれているので、他の形式の仮想マシンイメージファイルと同様に扱うことができます。

公式の Red Hat Enterprise Linux クラウドイメージをダウンロードするには、お使いのアカウントに有効な Red Hat Enterprise Linux サブスクリプションが必要です。

カスタマーポータルにログインしていない場合には、Red Hat アカウントの認証情報を入力するように求められます。

1.1. Image サービスについての理解

OpenStack Image サービス (glance) は、以下のような注目すべき機能を提供しています。

1.1.1. イメージの署名および検証

イメージの署名および検証により、デプロイ担当者がイメージに署名して、その署名と公開鍵の証明書をイメージのプロパティーとして保存できるようにすることで、イメージの整合性と信頼性を保護します。

この機能を活用すると、以下が可能になります。

- 秘密鍵を使用してイメージに署名し、そのイメージ、署名、公開鍵の証明書 (検証メタデータ) への参照をアップロードすることができます。Image サービスは、署名が有効かどうかを検証します。

- Compute サービスでイメージを作成し、Compute サービスがそのイメージに署名し、イメージや検証メタデータをアップロードすることができます。Image サービスは、この場合も、署名が有効であるかどうかを検証します。

- Compute サービスで署名済みのイメージを要求することができます。Image サービスは、イメージと検証メタデータを提供します。これにより、Compute サービスはイメージを起動する前に検証することができます。

イメージの署名および検証に関する詳しい情報は、『 Manage Secrets with OpenStack Key Manager』 の「 Validate Glance images」の章を参照してください。

1.1.2. イメージの変換

イメージの変換は、イメージのインポート中にタスク API を呼び出して、イメージを変換します。

インポートのワークフローの一環として、プラグインがイメージの変換機能を提供します。このプラグインは、デプロイ担当者の設定に基づいて、アクティブ化/非アクティブ化することができます。そのため、デプロイ担当者は、デプロイメントに希望のイメージ形式を指定する必要があります。

内部では、Image サービスが特定の形式でイメージのビットを受信します。これらのビットは、一時的な場所に保管されます。次にプラグインが起動されて、イメージを対象のフォーマットに変換し、最終的な保管場所に移動します。タスクが終了すると、一時的な場所は削除されます。このため、Image サービスでは最初にアップロードした形式は保持されません。

イメージの変換についての詳細は、「イメージ変換の有効化」を参照してください。

イメージの変換は、イメージをインポートする時にだけトリガーされます。イメージのアップロード時には実行されません。以下に例を示します。

1.1.3. イメージのイントロスペクション

イメージ形式はすべて、イメージ自体の中にメタデータセットが埋め込まれた状態で提供されます。たとえば、ストリーム最適化 VMDK には、以下のようなパラメーターが含まれます。

この vmdk をイントロスペクションすることにより、disk_type が streamOptimized で、adapter_type が buslogic であることを簡単に確認することができます。これらのメタデータパラメーターは、イメージのコンシューマーに役立ちます。Compute では、streamOptimized ディスクをインスタンス化するワークフローは、flat ディスクをインスタンス化するワークフローとは完全に異なります。この新機能により、メタデータの抽出が可能となります。イメージのイントロスペクションは、イメージのインポート中に、タスク API を呼び出すことによって実行できます。管理者は、メタデータの設定をオーバーライドすることができます。

1.1.4. 相互運用可能なイメージのインポート

OpenStack Image サービスでは、相互運用可能なイメージインポートワークフローを使用して、イメージをインポートするための 2 つの方法が提供されています。

-

URI からイメージをインポートする

web-download(デフォルト) -

ローカルファイルシステムからインポートする

glance-direct

1.1.5. Image サービスのキャッシュ機能を使用したスケーラビリティーの向上

glance-api キャッシュメカニズムを使用して、ローカルマシンにイメージのコピーを保存し、イメージを自動的に取得してスケーラビリティーを向上させます。Image サービスのキャッシュ機能を使用することで、複数のホスト上で glance-api を実行することができます。つまり、同じイメージをバックエンドストレージから何度も取得する必要はありません。Image サービスのキャッシュ機能は、Image サービスの動作には一切影響を与えません。

Red Hat OpenStack Platform director (tripleo) heat テンプレートを使用して Image サービスのキャッシュ機能を設定するには、以下の手順を実施します。

手順

環境ファイルの

GlanceCacheEnabledパラメーターの値をtrueに設定します。これにより、glance-api.confHeat テンプレートのflavorの値が自動的にkeystone+cachemanagementに設定されます。parameter_defaults: GlanceCacheEnabled: trueparameter_defaults: GlanceCacheEnabled: trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

オーバークラウドを再デプロイする際に、

openstack overcloud deployコマンドにその環境ファイルを追加します。 オプション: オーバークラウドを再デプロイする際に、

glance_cache_prunerを異なる頻度に調節します。5 分間の頻度の例を以下に示します。parameter_defaults: ControllerExtraConfig: glance::cache::pruner::minute: '*/5'parameter_defaults: ControllerExtraConfig: glance::cache::pruner::minute: '*/5'Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルシステムを使い果たす状況を回避するために、ご自分のニーズに合わせて頻度を調節します。異なる頻度を選択する場合は、以下の要素を考慮に入れます。

- 実際の環境でキャッシュするファイルのサイズ

- 利用可能なファイルシステムの容量

- 環境がイメージをキャッシュする頻度

1.1.6. イメージの事前キャッシュ

この機能は、本リリースでは テクノロジープレビュー として提供しているため、Red Hat では全面的にはサポートしていません。これは、テスト用途にのみご利用いただく機能で、実稼働環境にデプロイすべきではありません。テクノロジープレビュー機能についての詳しい情報は、「対象範囲の詳細」を参照してください。

1.1.6.1. 定期的にイメージを事前キャッシュする際のデフォルト間隔の設定

Red Hat OpenStack Platform director は、glance-api サービスの一部としてイメージを事前キャッシュできるようになったので、イメージを事前キャッシュするのに glance-registry は必要なくなりました。デフォルトの間隔は 300 秒です。実際の要件に応じて、デフォルトの間隔を増減することができます。

手順

アンダークラウドの環境ファイルの

ExtraConfigパラメーターを使用して、実際の要件に応じて新しい間隔を追加します。parameter_defaults: ControllerExtraConfig: glance::config::glance_api_config: DEFAULT/cache_prefetcher_interval: value: '<300>'parameter_defaults: ControllerExtraConfig: glance::config::glance_api_config: DEFAULT/cache_prefetcher_interval: value: '<300>'Copy to Clipboard Copied! Toggle word wrap Toggle overflow <300> を、イメージを事前キャッシュする間隔の秒数に置き換えてください。

/home/stack/templates/の環境ファイルで間隔を修正したら、stackユーザーとしてログインして設定をデプロイします。openstack overcloud deploy --templates \ -e /home/stack/templates/<ENV_FILE>.yaml

$ openstack overcloud deploy --templates \ -e /home/stack/templates/<ENV_FILE>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow <ENV_FILE> は、追加した

ExtraConfig設定が含まれる環境ファイルの名前に置き換えてください。

オーバークラウドの作成時に追加の環境ファイルを渡した場合には、予定外の変更がオーバークラウドに加えられないように、ここで -e オプションを使用して環境ファイルを再度渡します。

openstack overcloud deploy コマンドについての詳しい情報は、『 director のインストールと使用方法』 の「 デプロイメントコマンド 」を参照してください。

1.1.6.2. 定期的なジョブを使用したイメージの事前キャッシュ

前提条件

定期的なジョブを使用してイメージを事前キャッシュするには、glance_api サービスを実行しているノードに直接接続された glance-cache-manage コマンドを使用する必要があります。サービスの要求に応答するノードを非表示にするプロキシーは使用しないでください。アンダークラウドは glance_api サービスを実行しているネットワークにアクセスできない可能性があるため、最初のオーバークラウドノード (デフォルトでは controller-0 という名前です) でコマンドを実行します。

以下のアクションを確認するには、以下の前提条件の手順を実行します。

- 適切なホストからコマンドを実行します。

- 必要な認証情報がある。

glance-apiコンテナー内からglance-cache-manageコマンドを実行している。アンダークラウドに

stackユーザーとしてログインし、controller-0のプロビジョニング IP アドレスを特定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow オーバークラウドに対して認証するには、

/home/stack/overcloudrc(デフォルト) に保存されている認証情報をcontroller-0にコピーします。scp ~/overcloudrc heat-admin@192.168.24.71:/home/heat-admin/

(overcloud) [stack@undercloud-0 ~]$ scp ~/overcloudrc heat-admin@192.168.24.71:/home/heat-admin/Copy to Clipboard Copied! Toggle word wrap Toggle overflow controller-0にheat-adminユーザーとして接続します。ssh heat-admin@192.168.24.71

(overcloud) [stack@undercloud-0 ~]$ ssh heat-admin@192.168.24.71Copy to Clipboard Copied! Toggle word wrap Toggle overflow controller-0において、heat-adminユーザーとしてglance_api serviceの IP アドレスを特定します。以下の例では、IP アドレスは172.25.1.105です。sudo grep -A 10 '^listen glance_api' /var/lib/config-data/puppet-generated/haproxy/etc/haproxy/haproxy.cfg listen glance_api server controller0-0.internalapi.redhat.local 172.25.1.105:9292 check fall 5 inter 2000 rise 2 ...

[heat-admin@controller-0 ~]$ sudo grep -A 10 '^listen glance_api' /var/lib/config-data/puppet-generated/haproxy/etc/haproxy/haproxy.cfg listen glance_api server controller0-0.internalapi.redhat.local 172.25.1.105:9292 check fall 5 inter 2000 rise 2 ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 「glance-cache-manage\」コマンドは

glance_apiコンテナーでしか利用できないので、オーバークラウド認証の環境変数がすでに設定されているコンテナーに対して実行するスクリプトを作成する必要があります。controller-0の/home/heat-adminに、以下の内容でスクリプトglance_pod.shを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow source コマンドで

overcloudrcファイルを読み込み、glance_pod.shスクリプトを実行して、オーバークラウドのコントローラーノードに対して認証するのに必要な環境変数が設定されているglance_apiコンテナーに対して実行します。source overcloudrc (overcloudrc) [heat-admin@controller-0 ~]$ bash glance_pod.sh ()[glance@controller-0 /]$

[heat-admin@controller-0 ~]$ source overcloudrc (overcloudrc) [heat-admin@controller-0 ~]$ bash glance_pod.sh ()[glance@controller-0 /]$Copy to Clipboard Copied! Toggle word wrap Toggle overflow glance image-list等のコマンドを使用して、コンテナーでオーバークラウドに対して認証されたコマンドを実行できることを確認します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

管理ユーザーとして、キャッシュするイメージをキューに追加します。

()[glance@controller-0 /]$ glance-cache-manage --host=<HOST-IP> queue-image <IMAGE-ID>

()[glance@controller-0 /]$ glance-cache-manage --host=<HOST-IP> queue-image <IMAGE-ID>Copy to Clipboard Copied! Toggle word wrap Toggle overflow <HOST-IP> を

glance-apiコンテナーが実行されているコントローラーノードの IP アドレスに、<IMAGE-ID> をキューに追加するイメージの ID に、それぞれ置き換えてください。事前キャッシュするイメージをキューに追加すると、cache_images定期ジョブはキューに追加されたすべてのイメージを同時に事前取得します。注記イメージキャッシュは各ノードにローカルなので、Red Hat OpenStack Platform が HA 構成でデプロイされている場合 (3、5、または 7 台のコントローラー)、

glance-cache-manageコマンドを実行する際に--hostオプションでホストのアドレスを指定する必要があります。以下のコマンドを実行して、イメージキャッシュ内のイメージを表示します。

()[glance@controller-0 /]$ glance-cache-manage --host=<HOST-IP> list-cached

()[glance@controller-0 /]$ glance-cache-manage --host=<HOST-IP> list-cachedCopy to Clipboard Copied! Toggle word wrap Toggle overflow <HOST-IP> を環境内のホストの IP アドレスに置き換えてください。

この手順を完了したら、コントローラーノードから overcloudrc ファイルを削除します。

関連情報

以下の目的で、さらに glance-cache-manage コマンドを使用することができます。

-

list-cached: 現在キャッシュされているすべてのイメージを一覧表示する。 -

list-queued: キャッシュするために現在キューに追加されているすべてのイメージを一覧表示する。 -

queue-image: キャッシュするためにイメージをキューに追加する。 -

delete-cached-image: キャッシュからイメージを削除する。 -

delete-all-cached-images: キャッシュからすべてのイメージを削除する。 -

delete-cached-image: キャッシュのキューからイメージを削除する。 -

delete-all-queued-images: キャッシュのキューからすべてのイメージを削除する。

1.2. イメージの管理

OpenStack Image サービス (glance) は、ディスクおよびサーバーイメージの検出、登録、および配信のサービスを提供します。サーバーイメージのコピーやスナップショットを作成して直ちに保管する機能を提供します。保管したイメージは、テンプレートとして使用し、新規サーバーを迅速に稼働させるのに使用することができます。これはサーバーのオペレーティングシステムをインストールしてサービスを個別に設定するよりも一貫性の高い方法です。

1.2.1. イメージの作成

本項では、Red Hat Enterprise Linux 7、Red Hat Enterprise Linux 6 または Windows の ISO ファイルを使用して、QCOW2 形式の OpenStack 互換イメージを手動で作成する手順について説明します。

1.2.1.1. Red Hat OpenStack Platform における KVM ゲストイメージの使用

すでに準備済みの RHEL KVM ゲスト QCOW2 イメージを使用することができます。

これらのイメージは、cloud-init を使用して設定されます。適切に機能させるには、ec2 互換のメタデータサービスを利用して SSH キーをプロビジョニングする必要があります。

準備済みの Windows KVM ゲスト QCOW2 イメージはありません。

KVM ゲストイメージでは、以下の点に注意してください。

-

KVM ゲストイメージでは

rootアカウントが無効になっていますが、cloud-userという名前の特別なユーザーにsudoアクセスが許可されています。 -

このイメージには

rootパスワードは設定されていません。

root パスワードは、/etc/shadow で 2 番目のフィールドに !! と記載することによりロックされます。

OpenStack インスタンスでは、OpenStack Dashboard またはコマンドラインから ssh キーペアを生成し、その鍵の組み合わせを使用して、インスタンスに対して root として SSH 公開認証を実行することを推奨します。

インスタンスの起動時には、この公開鍵がインスタンスに挿入されます。続いて、キーペア作成時にダウンロードされた秘密鍵を使用して認証を行うことができます。

キーペアを使用しない場合には、「インスタンスへの admin パスワード挿入」の手順を使用して設定されている admin パスワードを使用することができます。

Red Hat Enterprise Linux または Windows のカスタムイメージを作成する場合は、「Red Hat Enterprise Linux 7 イメージの作成」、「Red Hat Enterprise Linux 6 イメージの作成」、または「Windows イメージの作成」を参照してください。

1.2.1.2. Red Hat Enterprise Linux または Windows のカスタムイメージの作成

前提条件

- イメージを作成する Linux ホストマシン。これは、Linux パッケージをインストール/実行することのできる任意のマシンです。

-

libvirt、virt-manager (

dnf groupinstall -y @virtualizationのコマンドを実行)。ゲストオペレーティングシステムを作成するのに必要な全パッケージがインストールされます。 -

Libguestfs ツール (

dnf install -y libguestfs-tools-cのコマンドを実行)。仮想マシンイメージにアクセスして変更を行うためのツールセットがインストールされます。 - Red Hat Enterprise Linux 7 もしくは 6 ISO ファイル (RHEL 7.2 Binary DVD もしくは RHEL 6.8 Binary DVD を参照)、または Windows ISO ファイル。Windows ISO ファイルがない場合には、Microsoft TechNet Evaluation Center に移動して評価版イメージをダウンロードしてください。

-

キックスタートファイルを編集する必要がある場合にはテキストエディター (RHEL のみ)

アンダークラウドに libguestfs-tools パッケージをインストールする場合は、アンダークラウドの tripleo_iscsid サービスとのポートの競合を避けるために iscsid.socket を無効にします。

sudo systemctl disable --now iscsid.socket

$ sudo systemctl disable --now iscsid.socket

以下の手順では、プロンプトに [root@host]# と表示されているコマンドはすべて、お使いのホストマシンで実行する必要があります。

1.2.1.2.1. Red Hat Enterprise Linux 7 イメージの作成

本項では、Red Hat Enterprise Linux 7 の ISO ファイルを使用して、QCOW2 形式の OpenStack 互換イメージを手動で作成する手順について説明します。

以下に示したように

virt-installでインストールを開始します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドによりインスタンスが起動し、インストールプロセスが開始されます。

注記インスタンスが自動的に起動しない場合には、

virt-viewerのコマンドを実行して、コンソールを確認します。virt-viewer rhel7

[root@host]# virt-viewer rhel7Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の手順に従って、仮想マシンを設定します。

-

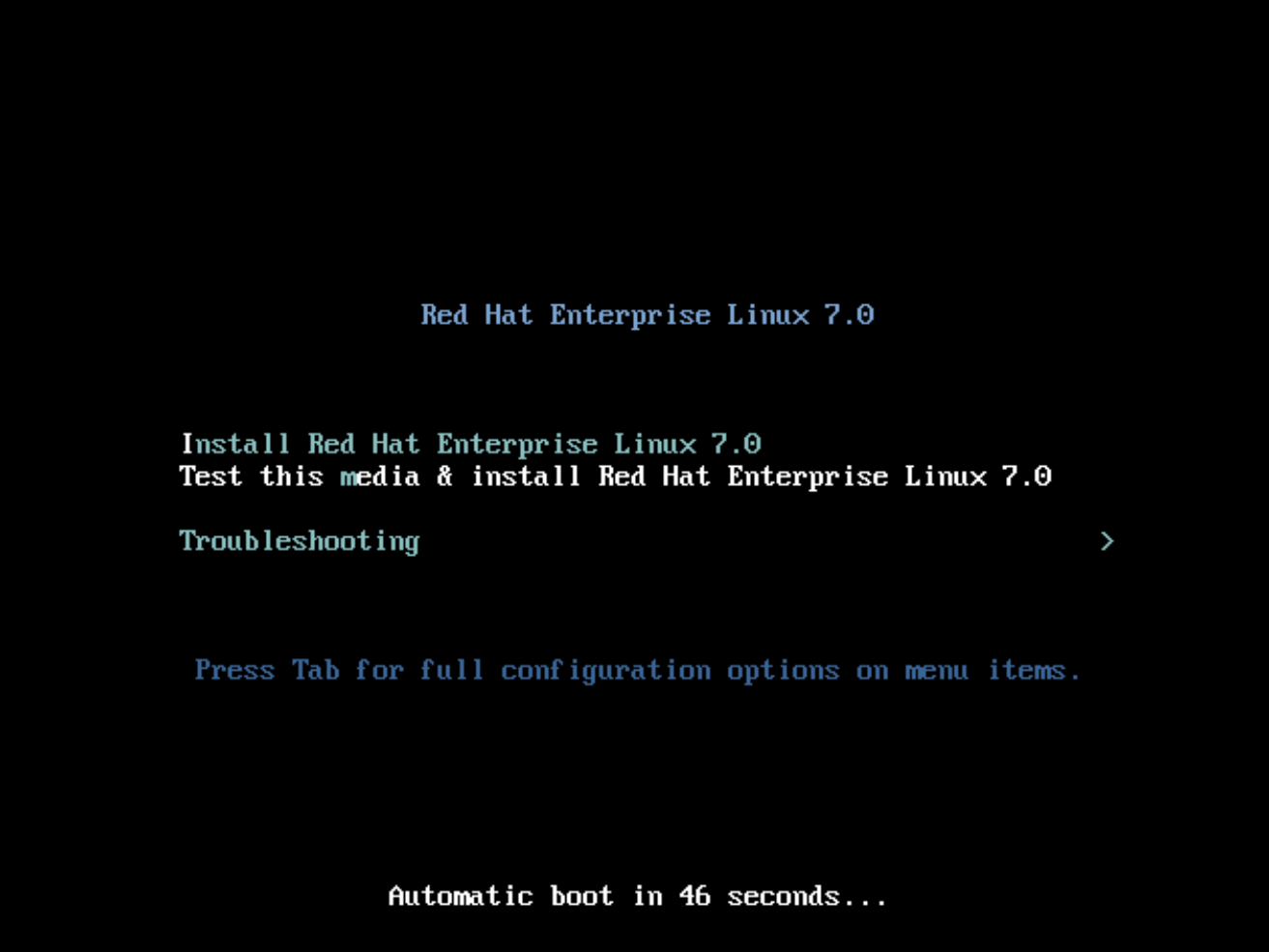

インストーラーの初期起動メニューで、

Install Red Hat Enterprise Linux 7.X のオプションを選択します。

- 適切な 言語 および キーボード オプションを選択します。

-

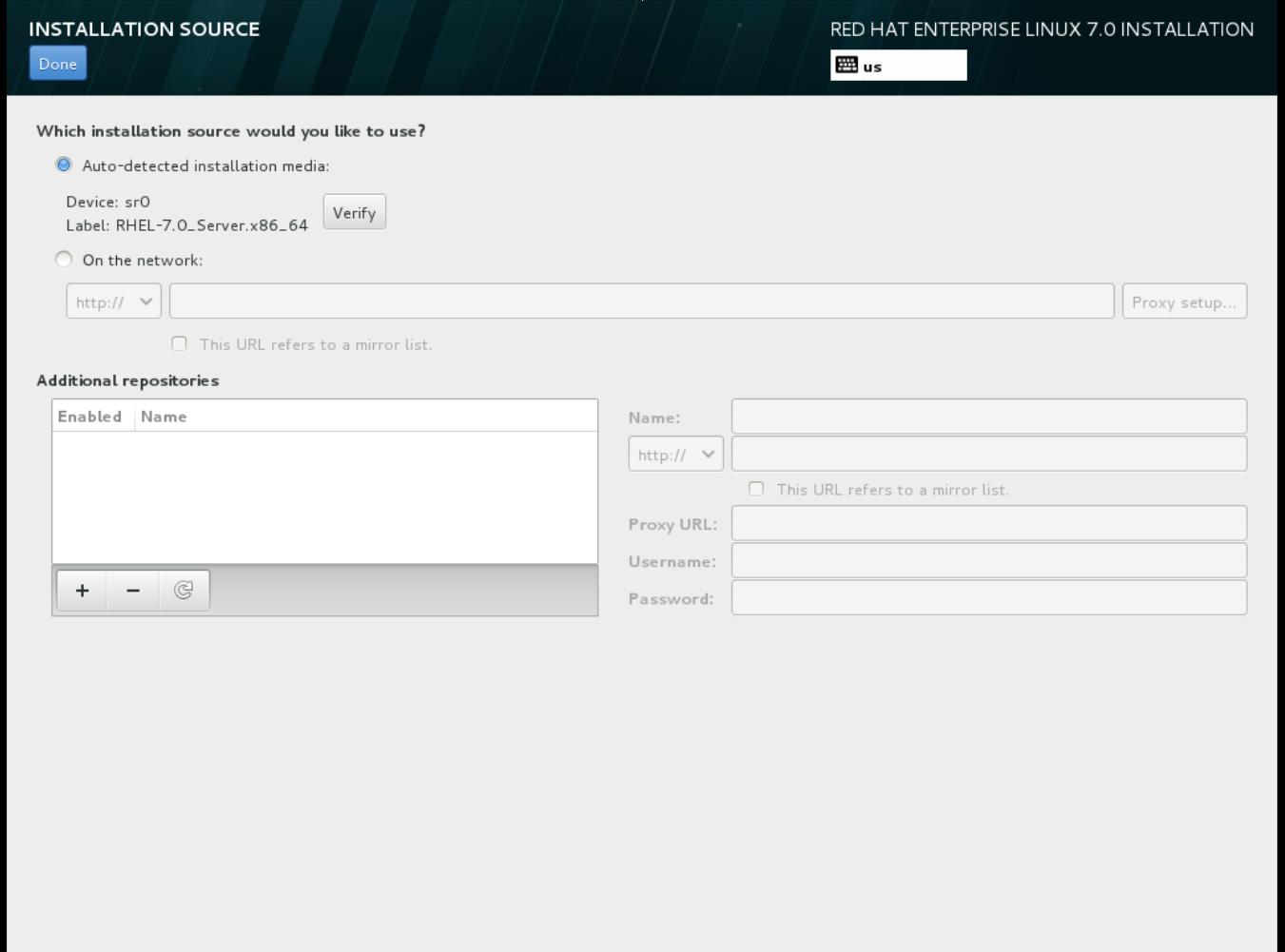

インストールに使用するデバイスタイプを尋ねるプロンプトが表示されたら、自動検出したインストールメディア を選択します。

-

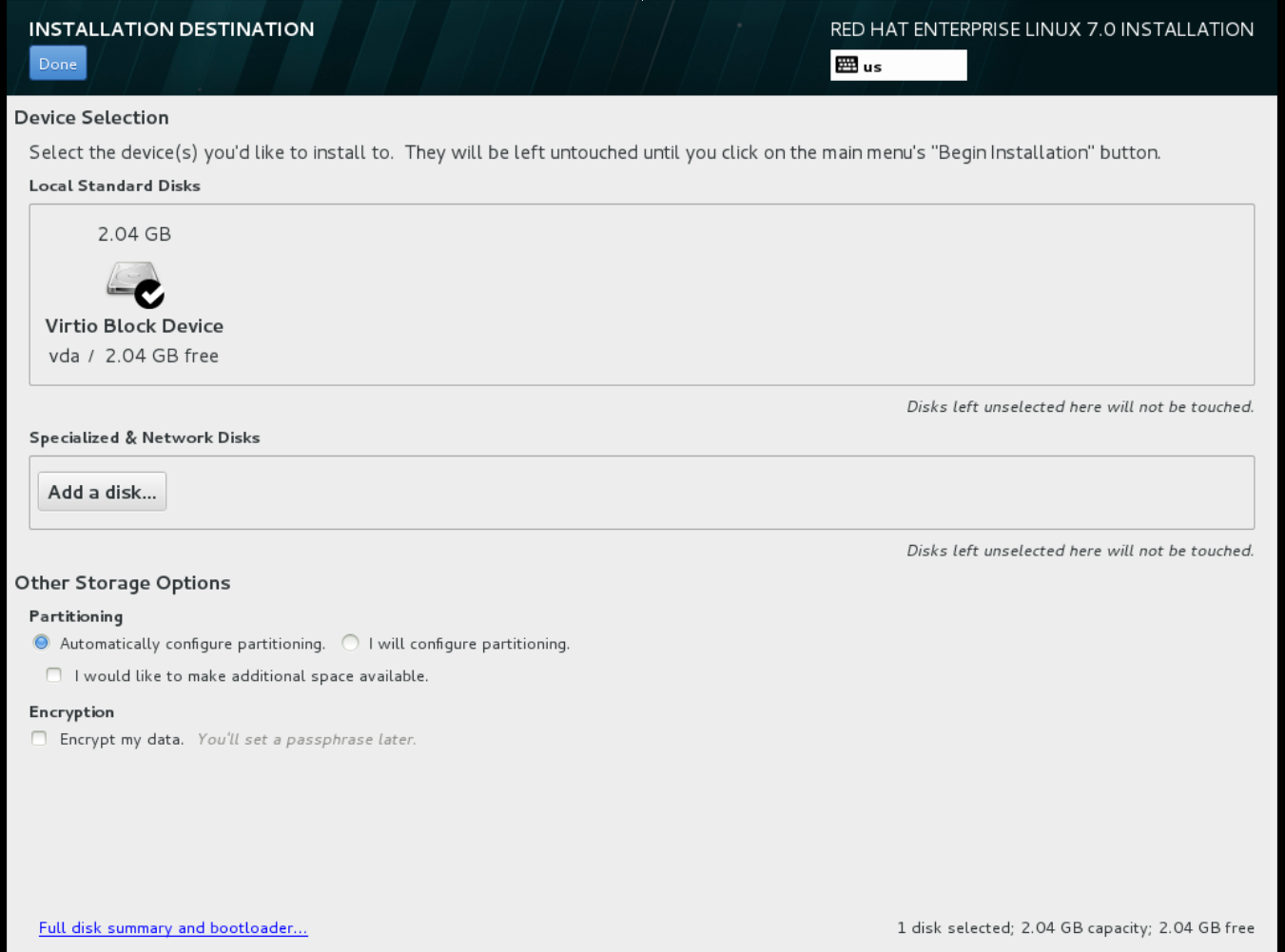

インストール先を尋ねるプロンプトが表示されたら、ローカルの標準ディスク を選択します。

その他のストレージタイプオプションには、自動構成のパーティション構成 を選択します。

その他のストレージタイプオプションには、自動構成のパーティション構成 を選択します。

- ソフトウェアのオプションには、最小限のインストール を選択します。

-

ネットワークとホスト名の設定では、イーサネットに

eth0を選択し、デバイスのホスト名を指定します。デフォルトのホスト名はlocalhost.localdomainです。 -

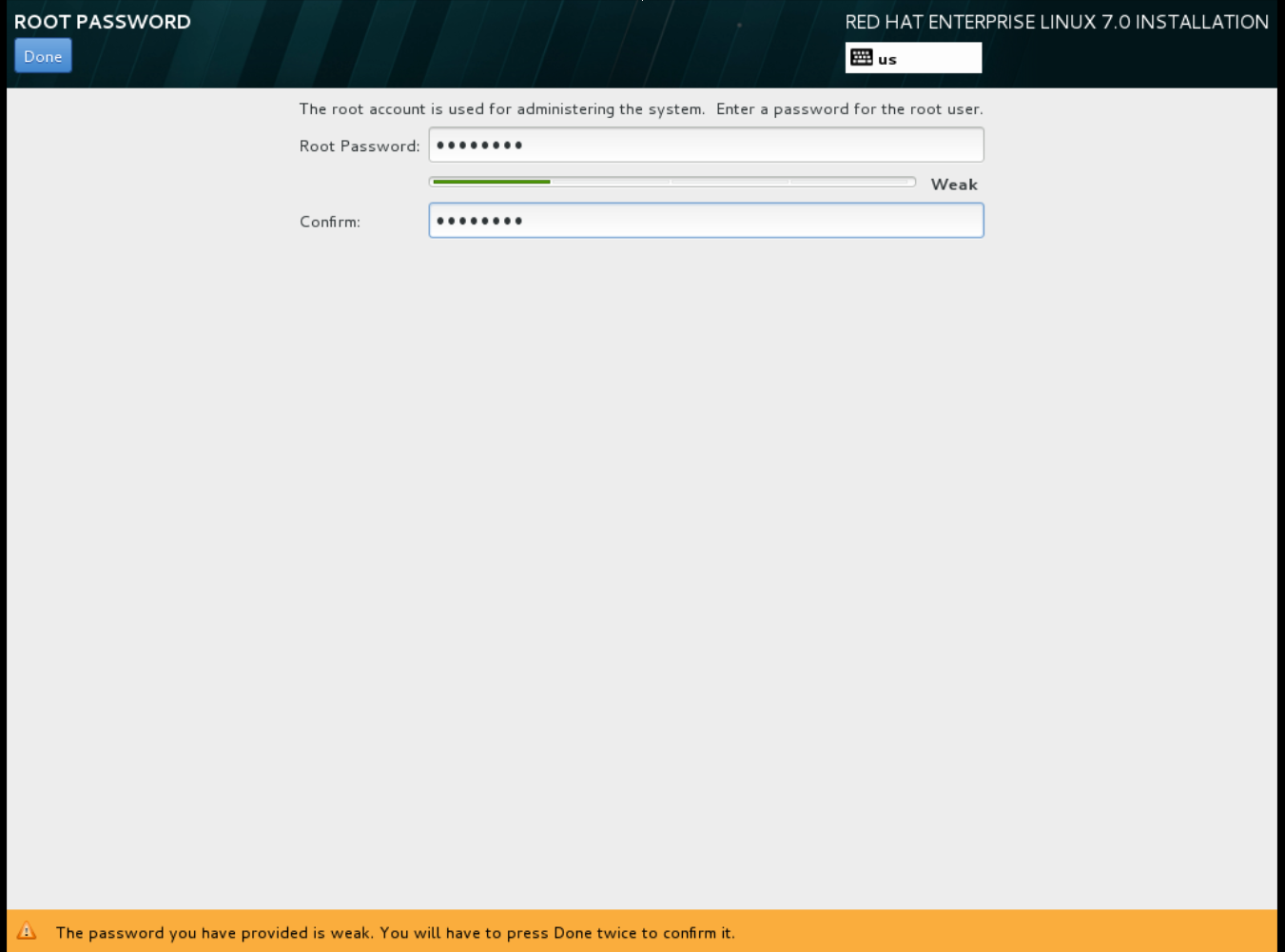

rootパスワードを選択します。 インストールプロセスが完了すると、完了しました! の画面が表示されます。

インストールプロセスが完了すると、完了しました! の画面が表示されます。

-

インストーラーの初期起動メニューで、

- インストールが完了した後には、インスタンスを再起動して、root ユーザーとしてログインします。

/etc/sysconfig/network-scripts/ifcfg-eth0ファイルを編集して、以下の値のみが記載されている状態にします。TYPE=Ethernet DEVICE=eth0 ONBOOT=yes BOOTPROTO=dhcp NM_CONTROLLED=no

TYPE=Ethernet DEVICE=eth0 ONBOOT=yes BOOTPROTO=dhcp NM_CONTROLLED=noCopy to Clipboard Copied! Toggle word wrap Toggle overflow - マシンを再起動します。

コンテンツ配信ネットワークにマシンを登録します。

sudo subscription-manager register sudo subscription-manager attach --pool=Valid-Pool-Number-123456 sudo subscription-manager repos --enable=rhel-7-server-rpms

# sudo subscription-manager register # sudo subscription-manager attach --pool=Valid-Pool-Number-123456 # sudo subscription-manager repos --enable=rhel-7-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow システムを更新します。

dnf -y update

# dnf -y updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow cloud-initパッケージをインストールします。dnf install -y cloud-utils-growpart cloud-init

# dnf install -y cloud-utils-growpart cloud-initCopy to Clipboard Copied! Toggle word wrap Toggle overflow /etc/cloud/cloud.cfg設定ファイルを編集して、cloud_init_modulesの下に以下を追加します。- resolv-conf

- resolv-confCopy to Clipboard Copied! Toggle word wrap Toggle overflow resolv-confオプションは、インスタンスの初回起動時にresolv.confを自動的に設定します。このファイルには、nameservers、domain、その他のオプションなどのインスタンスに関連した情報が記載されています。/etc/sysconfig/networkに以下の行を追加し、EC2 メタデータサービスへのアクセスで問題が発生するのを回避します。NOZEROCONF=yes

NOZEROCONF=yesCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンソールメッセージが Dashboard の

ログタブおよびnova console-logの出力に表示されるようにするには、以下のブートオプションを/etc/default/grubファイルに追記します。GRUB_CMDLINE_LINUX_DEFAULT="console=tty0 console=ttyS0,115200n8"

GRUB_CMDLINE_LINUX_DEFAULT="console=tty0 console=ttyS0,115200n8"Copy to Clipboard Copied! Toggle word wrap Toggle overflow grub2-mkconfigコマンドを実行します。grub2-mkconfig -o /boot/grub2/grub.cfg

# grub2-mkconfig -o /boot/grub2/grub.cfgCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のような出力が表示されます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 仮想マシンの登録を解除して、作成されるイメージをベースにクローン作成される全インスタンスに同じサブスクリプション情報が含まれないようにします。

subscription-manager repos --disable=* subscription-manager unregister dnf clean all

# subscription-manager repos --disable=* # subscription-manager unregister # dnf clean allCopy to Clipboard Copied! Toggle word wrap Toggle overflow インスタンスの電源をオフにします。

poweroff

# poweroffCopy to Clipboard Copied! Toggle word wrap Toggle overflow virt-sysprepコマンドでイメージのリセットおよびクリーニングをして、問題なくインスタンスの作成に使用できるようにします。virt-sysprep -d rhel7

[root@host]# virt-sysprep -d rhel7Copy to Clipboard Copied! Toggle word wrap Toggle overflow virt-sparsifyコマンドを使用してイメージのサイズを縮小します。このコマンドにより、ディスクイメージ内の空き容量は、ホスト内の空き容量に戻ります。virt-sparsify --compress /tmp/rhel7.qcow2 rhel7-cloud.qcow2

[root@host]# virt-sparsify --compress /tmp/rhel7.qcow2 rhel7-cloud.qcow2Copy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドを実行すると、その場所に

rhel7-cloud.qcow2ファイルが作成されます。

rhel7-cloud.qcow2 イメージファイルを Image サービスにアップロードする準備が整いました。Dashboard を使用して OpenStack デプロイメントにこのイメージをアップロードする方法については、「イメージのアップロード」を参照してください。

1.2.1.2.2. Red Hat Enterprise Linux 6 イメージの作成

本項では、Red Hat Enterprise Linux 6 の ISO ファイルを使用して、QCOW2 形式の OpenStack 互換イメージを手動で作成する手順について説明します。

virt-installでインストールを開始します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドによりインスタンスが起動し、インストールプロセスが開始されます。

注記インスタンスが自動的に起動しない場合には、

virt-viewerのコマンドを実行して、コンソールを確認します。virt-viewer rhel6

[root@host]# virt-viewer rhel6Copy to Clipboard Copied! Toggle word wrap Toggle overflow 仮想マシンを以下のように設定します。

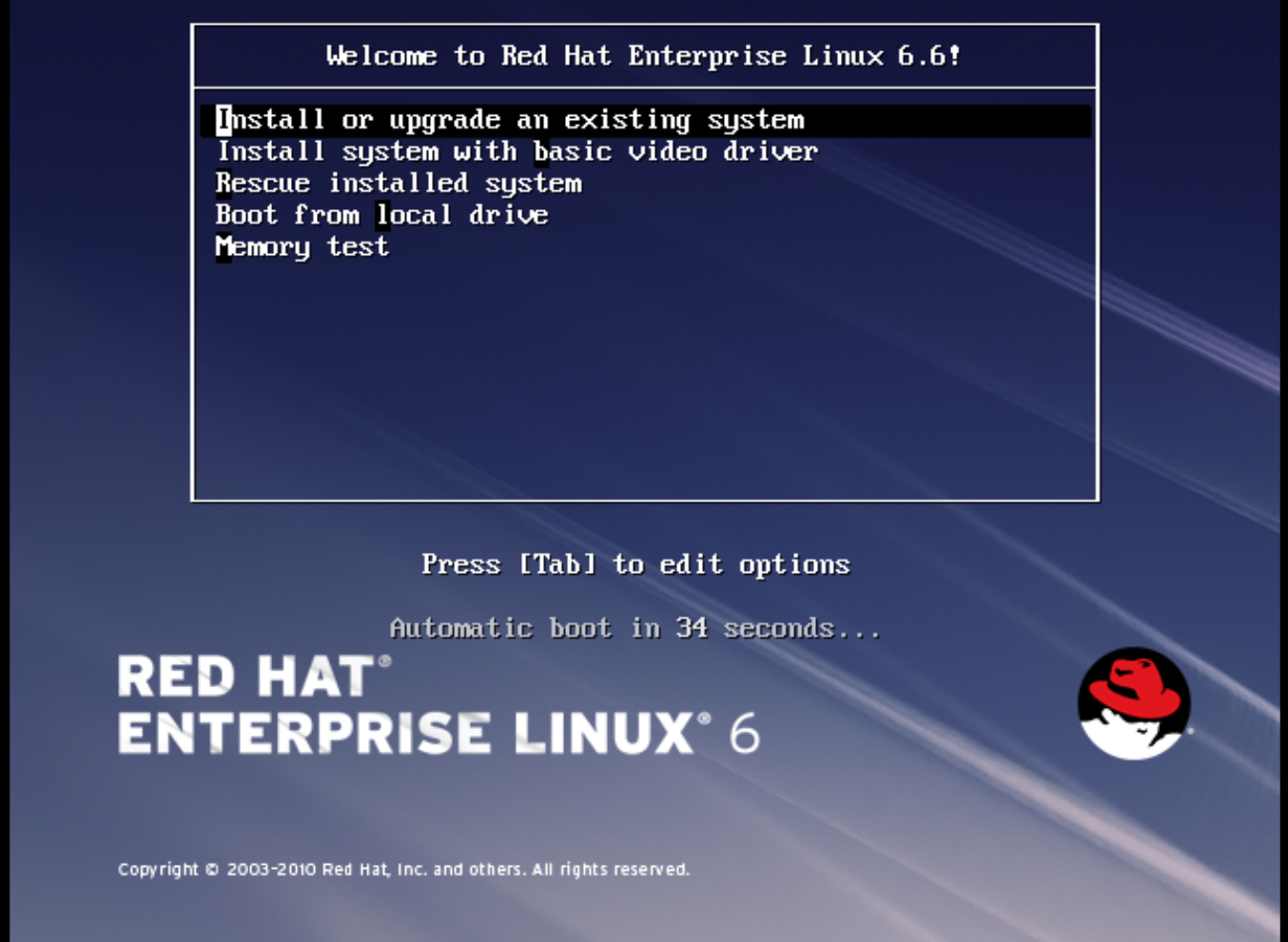

インストーラーの初期起動メニューで、Install or upgrade an existing system のオプションを選択します。

インストールのプロンプトに従って順に進みます。デフォルト値を受け入れます。

インストールのプロンプトに従って順に進みます。デフォルト値を受け入れます。

インストーラーは、ディスクの有無を確認して、インストール前にインストールメディアのテストを行うかどうかを決定するように促します。テストを実行するには OK を、テストを行わずに続行するには Skip を選択します。

- 適切な 言語 および キーボード オプションを選択します。

-

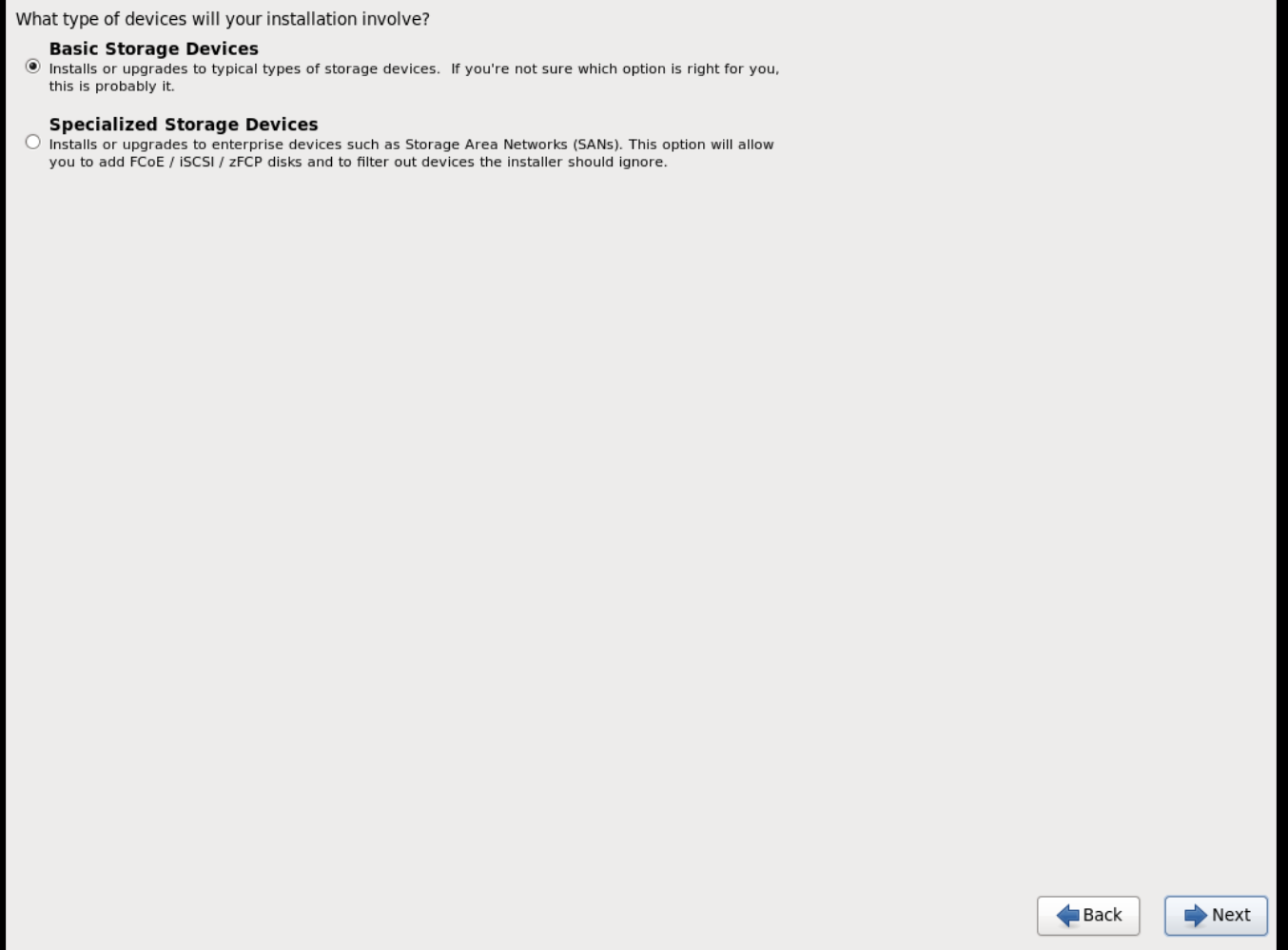

インストールに使用するデバイスタイプを尋ねるプロンプトが表示されたら、基本ストレージデバイス を選択します。

-

デバイスの

ホスト名を指定します。デフォルトのホスト名はlocalhost.localdomainです。 -

タイムゾーン と

rootパスワードを指定します。 -

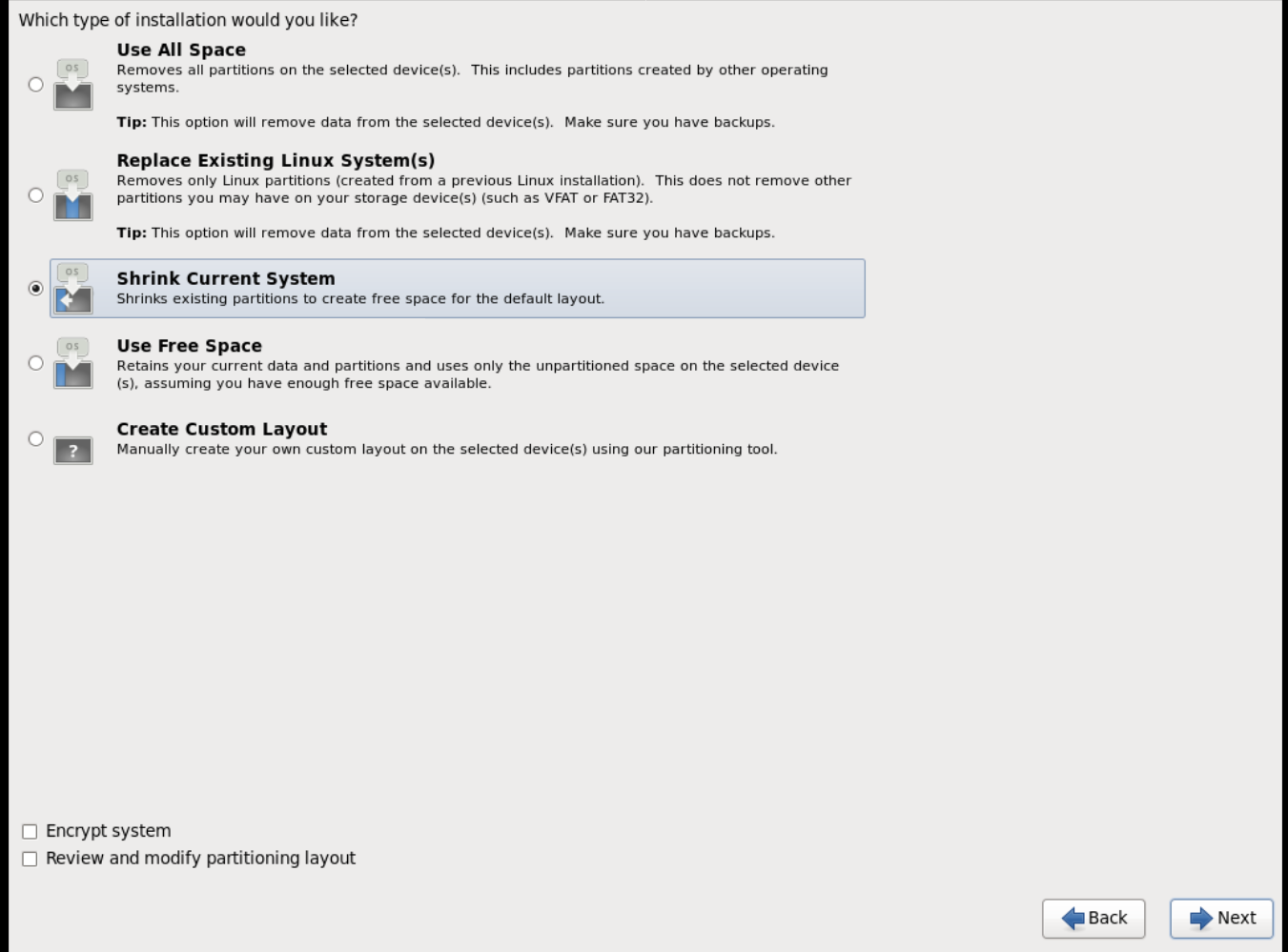

ディスクの空き容量に応じて、インストールのタイプを選択します。

-

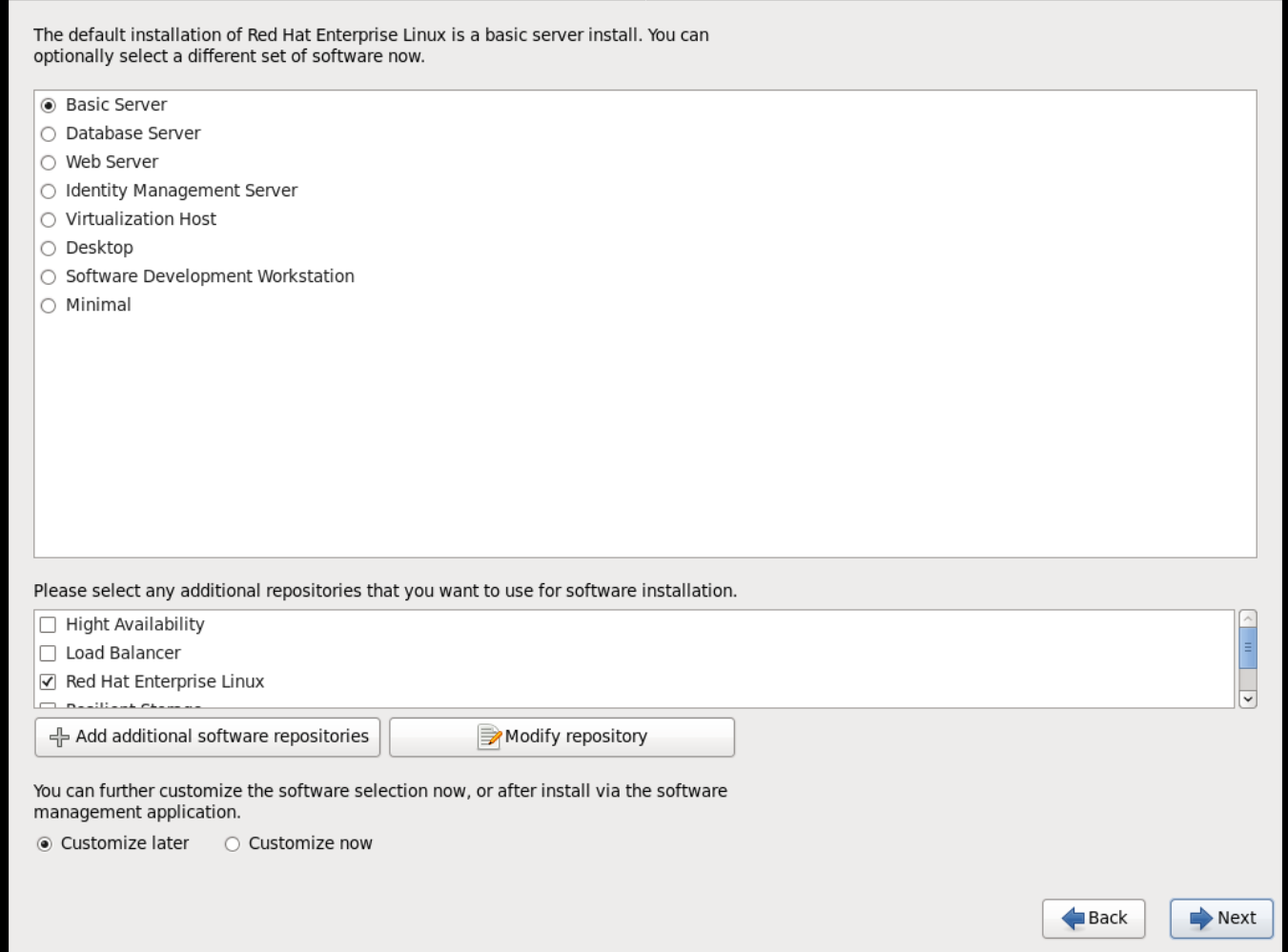

SSH サーバーをインストールする 基本サーバー インストールを選択します。

- インストールプロセスが完了し、おめでとうございます。Red Hat Enterprise Linux のインストールが完了しました。の画面が表示されます。

-

インスタンスを再起動して、

rootユーザーとしてログインします。 /etc/sysconfig/network-scripts/ifcfg-eth0ファイルを編集して、以下の値のみが記載されている状態にします。TYPE=Ethernet DEVICE=eth0 ONBOOT=yes BOOTPROTO=dhcp NM_CONTROLLED=no

TYPE=Ethernet DEVICE=eth0 ONBOOT=yes BOOTPROTO=dhcp NM_CONTROLLED=noCopy to Clipboard Copied! Toggle word wrap Toggle overflow - マシンを再起動します。

コンテンツ配信ネットワークにマシンを登録します。

sudo subscription-manager register sudo subscription-manager attach --pool=Valid-Pool-Number-123456 sudo subscription-manager repos --enable=rhel-6-server-rpms

# sudo subscription-manager register # sudo subscription-manager attach --pool=Valid-Pool-Number-123456 # sudo subscription-manager repos --enable=rhel-6-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow システムを更新します。

dnf -y update

# dnf -y updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow cloud-initパッケージをインストールします。dnf install -y cloud-utils-growpart cloud-init

# dnf install -y cloud-utils-growpart cloud-initCopy to Clipboard Copied! Toggle word wrap Toggle overflow /etc/cloud/cloud.cfg設定ファイルを編集して、cloud_init_modulesの下に以下を追加します。- resolv-conf

- resolv-confCopy to Clipboard Copied! Toggle word wrap Toggle overflow resolv-confオプションは、インスタンスの初回起動時にresolv.conf設定ファイルを自動的に設定します。このファイルには、nameservers、domain、その他のオプションなどのインスタンスに関連した情報が記載されています。ネットワークの問題が発生するのを防ぐために、以下のように

/etc/udev/rules.d/75-persistent-net-generator.rulesファイルを作成します。echo "#" > /etc/udev/rules.d/75-persistent-net-generator.rules

# echo "#" > /etc/udev/rules.d/75-persistent-net-generator.rulesCopy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、

/etc/udev/rules.d/70-persistent-net.rulesファイルが作成されるのを防ぎます。/etc/udev/rules.d/70-persistent-net.rulesが作成されてしまうと、スナップショットからのブート時にネットワークが適切に機能しなくなる可能性があります (ネットワークインターフェースが「eth0」ではなく「eth1」として作成され、IP アドレスが割り当てられません)。/etc/sysconfig/networkに以下の行を追加し、EC2 メタデータサービスへのアクセスで問題が発生するのを回避します。NOZEROCONF=yes

NOZEROCONF=yesCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンソールメッセージが Dashboard の

ログタブおよびnova console-logの出力に表示されるようにするには、以下のブートオプションを/etc/grub.confファイルに追記します。console=tty0 console=ttyS0,115200n8

console=tty0 console=ttyS0,115200n8Copy to Clipboard Copied! Toggle word wrap Toggle overflow 仮想マシンの登録を解除して、作成されるイメージをベースにクローン作成されるインスタンスすべてに同じサブスクリプション情報が含まれないようにします。

subscription-manager repos --disable=* subscription-manager unregister dnf clean all

# subscription-manager repos --disable=* # subscription-manager unregister # dnf clean allCopy to Clipboard Copied! Toggle word wrap Toggle overflow インスタンスの電源をオフにします。

poweroff

# poweroffCopy to Clipboard Copied! Toggle word wrap Toggle overflow virt-sysprepコマンドでイメージのリセットおよびクリーニングをして、問題なくインスタンスの作成に使用できるようにします。virt-sysprep -d rhel6

[root@host]# virt-sysprep -d rhel6Copy to Clipboard Copied! Toggle word wrap Toggle overflow virt-sparsifyコマンドを使用してイメージのサイズを縮小します。このコマンドにより、ディスクイメージ内の空き容量は、ホスト内の空き容量に戻ります。virt-sparsify --compress rhel6.qcow2 rhel6-cloud.qcow2

[root@host]# virt-sparsify --compress rhel6.qcow2 rhel6-cloud.qcow2Copy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドを実行すると、その場所に新しい

rhel6-cloud.qcow2ファイルが作成されます。注記インスタンスに適用されているフレーバーのディスクスペースに応じて、イメージをベースとするインスタンスのパーティションを手動でリサイズする必要があります。

rhel6-cloud.qcow2 イメージファイルを Image サービスにアップロードする準備が整いました。Dashboard を使用して OpenStack デプロイメントにこのイメージをアップロードする方法については、「イメージのアップロード」を参照してください。

1.2.1.2.3. Windows イメージの作成

本項では、Windows の ISO ファイルを使用して、QCOW2 形式の OpenStack 互換イメージを手動で作成する手順について説明します。

以下に示したように

virt-installでインストールを開始します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のように

virt-installパラメーターの値を置き換えます。- name: Windows ゲストに指定する必要のある名前

- size: ディスクのサイズ (GB)

- path: Windows のインストール ISO ファイルへのパス

RAM: 要求するメモリー容量 (MB)

注記--os-type=windowsパラメーターにより、Windows ゲストのクロックが正しく設定され、Hyper-V エンライトメント機能が有効化されるようになります。デフォルトでは、

virt-installは/var/lib/libvirt/images/name.qcow2としてゲストイメージを保存します。ゲストイメージを別の場所に保存するには、以下のように--diskのオプションを変更してください。--disk path=filename,size=size

--disk path=filename,size=sizeCopy to Clipboard Copied! Toggle word wrap Toggle overflow filename は、ゲストイメージを保存する必要のあるファイル名 (およびオプションでそのパス) に置き換えてください。たとえば、

path=win8.qcow2,size=8は現在の作業ディレクトリーにwin8.qcow2という名前の 8 GB のファイルを作成します。ヒントゲストが自動的に起動しない場合には、

virt-viewerのコマンドを実行して、コンソールを確認します。virt-viewer name

[root@host]# virt-viewer nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- Windows システムのインストールは、本書の対象範囲外となります。Windows のインストール方法に関する説明は、適切な Microsoft のドキュメントを参照してください。

-

新規インストールした Windows システムで仮想化ハードウェアを使用できるようにするには、virtio ドライバー をインストールしなければならない場合があります。これには、まずホストシステムで

virtio-winパッケージをインストールします。このパッケージには virtio ISO イメージが含まれており、そのイメージを CD-ROM ドライブとして Windows ゲストにアタッチします。virtio-winパッケージをインストールするには、ゲストに virtio ISO イメージを追加して、virtio ドライバーをインストールする必要があります。『仮想化の設定および管理』の「Windows 仮想マシン用の KVM 準仮想化ドライバーのインストール」を参照してください。 Windows システムで Cloudbase-Init をダウンロード、実行して、設定を完了します。Cloudbase-Init のインストールの最後に、

Run SysprepとShutdownチェックボックスを選択します。Sysprepツールは、特定の Microsoft サービスで使用する OS ID を生成して、ゲストを一意にします。重要Red Hat は Cloudbase-Init に関するテクニカルサポートは提供しません。問題が発生した場合には、contact Cloudbase Solutions からお問い合わせください。

Windows システムがシャットダウンしたら、name.qcow2 イメージファイルを Image サービスにアップロードすることができます。Dashboard またはコマンドラインを使用して OpenStack デプロイメントにこのイメージをアップロードする方法については、「イメージのアップロード」を参照してください。

1.2.1.3. libosinfo の使用

Image サービス (glance) はイメージ用に libosinfo のデータを処理して、インスタンスに最適な仮想ハードウェアをより簡単に設定できるようにすることができます。これは、libosinfo 形式のオペレーティングシステム名前を glance イメージに追加することによって行うことができます。

以下の例では、ID

654dbfd5-5c01-411f-8599-a27bd344d79bのイメージがrhel7.2という libosinfo の値を使用するように指定します。openstack image set 654dbfd5-5c01-411f-8599-a27bd344d79b --property os_name=rhel7.2

$ openstack image set 654dbfd5-5c01-411f-8599-a27bd344d79b --property os_name=rhel7.2Copy to Clipboard Copied! Toggle word wrap Toggle overflow その結果、Compute は、

654dbfd5-5c01-411f-8599-a27bd344d79bのイメージを使用してインスタンスがビルドされる際に必ず、rhel7.2向けに最適化された仮想ハードウェアを提供するようになります。注記libosinfoの値の完全な一覧は、libosinfo プロジェクトを参照してください (https://gitlab.com/libosinfo/osinfo-db/tree/master/data/os)。

1.2.2. イメージのアップロード

- Dashboard で プロジェクト > コンピュート > イメージ を選択します。

- イメージの作成 をクリックします。

- 各フィールドに値を入力し、完了したら イメージの作成 をクリックします。

| フィールド | 説明 |

|---|---|

| 名前 | イメージの名前。そのプロジェクト内で一意な名前にする必要があります。 |

| 説明 | イメージを識別するための簡単な説明 |

| イメージソース | イメージソース: イメージの場所 または イメージファイル。ここで選択したオプションに応じて次のフィールドが表示されます。 |

| イメージの場所またはイメージファイル |

|

| 形式 | イメージの形式 (例: qcow2) |

| アーキテクチャー | イメージのアーキテクチャー。たとえば 32 ビットのアーキテクチャーには i686、64 ビットのアーキテクチャーには x86_64 を使用します。 |

| 最小ディスク (GB) | イメージのブートに必要な最小のディスクサイズ。このフィールドに値が指定されていない場合には、デフォルト値は 0 です (最小値なし)。 |

| 最小メモリー (MB) | イメージのブートに必要な最小のメモリーサイズ。このフィールドに値が指定されていない場合には、デフォルト値は 0 です (最小値なし)。 |

| パブリック | このチェックボックスを選択した場合には、プロジェクトにアクセスできる全ユーザーにイメージが公開されます。 |

| 保護 | このチェックボックスを選択した場合には、特定のパーミッションのあるユーザーのみがこのイメージを削除できるようになります。 |

イメージが正常にアップロードされたら、イメージのステータスは、イメージが使用可能であることを示す active に変わります。Image サービスは、アップロードの開始時に使用した Identity サービストークンのライフタイムよりもアップロードの所要時間が長くかかる大容量のイメージも処理することができる点に注意してください。これは、アップロードが完了してイメージのステータスが更新される際に、新しいトークンを取得して使用できるように、Identity サービスは最初に Identity サービスとのトラストを作成するためです。

glance image-create コマンドに property のオプションを指定して実行する方法でイメージをアップロードすることもできます。コマンドラインで操作を行った方が、より多くの値を使用することができます。完全なリストは、「イメージの設定パラメーター」を参照してください。

1.2.3. イメージの更新

- Dashboard で プロジェクト > コンピュート > イメージ を選択します。

ドロップダウンリストから イメージの編集 をクリックします。

注記イメージの編集 オプションは、

adminユーザーとしてログインした場合にのみ使用することができます。demoユーザーとしてログインした場合には、インスタンスの起動 または ボリュームの作成 のオプションを使用することができます。- フィールドを更新して、終了したら イメージの更新 をクリックします。次の値を更新することができます (名前、説明、カーネル ID、RAM ディスク ID、アーキテクチャー、形式、最小ディスク、最小メモリー、パブリック、保護)。

- ドロップダウンメニューをクリックして メタデータの更新 オプションを選択します。

- 左のコラムから右のコラムに項目を追加して、メタデータを指定します。左のコラムには、Image サービスのメタデータカタログからのメタデータの定義が含まれています。その他 を選択して、任意のキーを使用してメタデータを追加し、完了したら 保存 をクリックします。

glance image-update コマンドに property オプションを指定して実行する方法でイメージを更新することもできます。コマンドラインで操作を行った方が、より多くの値を使用することができます。完全なリストは、「イメージの設定パラメーター」を参照してください。

1.2.4. イメージのインポート

URI からイメージをインポートする web-download と ローカルファイルシステムからイメージをインポートする glance-direct を使用して、Image サービス (glance) にイメージをインポートすることができます。デフォルトでは、両方のオプションが有効です。

インポートの方法は、クラウド管理者によって設定されます。glance import-info コマンドを実行して、利用可能なインポートオプションを一覧表示します。

1.2.4.1. リモート URI からのインポート

web-download メソッドを使用して、リモートの URI からイメージをコピーすることができます。

イメージを作成して、インポートするイメージの URI を指定します。

glance image-create --uri <URI>

glance image-create --uri <URI>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

glance image-show <image-ID>コマンドで、イメージの可用性をモニタリングすることができます。ここで ID は、イメージの作成中に提供された ID に置き換えてください。

Image サービスの web-download メソッドでは、2 段階のプロセスでインポートを実施します。まず、イメージのレコードを作成します。次に、指定した URI からイメージを取得します。このメソッドは、Image API v1 で使用されていた非推奨となった copy-from メソッドよりもセキュアにイメージをインポートする方法です。

『Advanced Overcloud Customization』で説明するように、URI にオプションのブラックリストおよびホワイトリストによる絞り込みを適用することができます。

『オーバークラウドの高度なカスタマイズ』で説明するように、Image Property Injection プラグインにより、イメージにメタデータ属性を注入することができます。注入されたこれらの属性により、イメージインスタンスを起動するコンピュートノードが決定されます。

1.2.4.2. ローカルボリュームからのインポート

glance-direct メソッドは、イメージレコードを作成し、それによりイメージ ID が生成されます。ローカルボリュームからイメージがサービスにアップロードされるとステージングエリアに保管され、設定されているチェックに合格した後にアクティブとなります。高可用性 (HA) 構成で使用される場合には、glance-direct メソッドには共通のステージングエリアが必要です。

HA 環境では、glance-direct メソッドを使用したイメージのアップロードは、共通のステージエリアがない場合には失敗します。HA の Active/Active 環境では、API コールは複数の glance コントローラーに分散されます。ダウンロード API コールは、イメージをアップロードする API コールとは別のコントローラーに送信することが可能です。ステージングエリアの設定に関する詳しい情報は、『オーバークラウドの 高度なカスタマイズ』 の「 ストレージの設定 」セクションを参照してください。

glance-direct メソッドは、3 つの異なるコールを使用して、イメージをインポートします。

-

glance image-create -

glance image-stage -

glance image-import

glance image-create-via-import コマンドを使用すると、これらの 3 つのコールを 1 つのコマンドで実行することができます。以下の例では、大文字の語句は適切なオプションに置き換える必要があります。

glance image-create-via-import --container-format FORMAT --disk-format DISKFORMAT --name NAME --file /PATH/TO/IMAGE

glance image-create-via-import --container-format FORMAT --disk-format DISKFORMAT --name NAME --file /PATH/TO/IMAGEイメージがステージングエリアからバックエンドの場所に移動すると、そのイメージはリストされます。ただし、イメージがアクティブになるには、多少時間がかかる場合があります。

glance image-show <image-ID> コマンドで、イメージの可用性をモニタリングすることができます。ここで ID は、イメージの作成中に提供された ID に置き換えてください。

1.2.5. イメージの削除

- Dashboard で プロジェクト > コンピュート > イメージ を選択します。

- 削除するイメージを選択し、イメージの削除 ボタンをクリックします。

1.2.6. イメージの表示または非表示

ユーザーに表示される通常の一覧からパブリックイメージを非表示にすることができます。たとえば、廃止された CentOS 7 イメージを非表示にし、最新バージョンだけを表示してユーザーエクスペリエンスをシンプル化することができます。ユーザーは、非表示のイメージを検出して使用することができます。

イメージを非表示にするには、以下をコマンドを実行します。

glance image-update <image-id> --hidden 'true'

glance image-update <image-id> --hidden 'true'

非表示のイメージを作成するには、glance image-create コマンドに --hidden 引数を追加します。

イメージの非表示を解除するには、以下のコマンドを実行します。

glance image-update <image-id> --hidden 'false'

glance image-update <image-id> --hidden 'false'1.2.8. イメージ変換の有効化

GlanceImageImportPlugins パラメーターを有効にすると、QCOW2 イメージをアップロードすることができ、Image サービスはそのイメージを RAW に変換します。

Red Hat Ceph Storage RBD を使用してイメージを保存して Nova インスタンスをブートすると、イメージの変換は自動的に有効になります。

イメージの変換を有効にするには、以下のパラメーター値が含まれる環境ファイルを作成し、-e オプションを使用して新しい環境ファイルを openstack overcloud deploy コマンドに追加します。

parameter_defaults: GlanceImageImportPlugins:'image_conversion'

parameter_defaults:

GlanceImageImportPlugins:'image_conversion'1.2.9. RAW 形式へのイメージの変換

Red Hat Ceph Storage は QCOW2 イメージを保管することはできますが、そのイメージを使用して仮想マシン (VM) のディスクをホストすることはできません。

アップロードした QCOW2 イメージから仮想マシンを作成する場合には、コンピュートノードはイメージをダウンロードして RAW に変換し、それを Ceph にアップロードし直してからでないと使用することができません。このプロセスは仮想マシンの作成時間に影響を及ぼします (特に、並行して仮想マシンを作成する場合)。

たとえば、複数の仮想マシンを同時に作成する場合には、Ceph クラスターへの変換済みイメージのアップロードが、すでに実行中の負荷に影響を及ぼす可能性があります。IOPS のこれらの負荷に対するリソースがアップロードプロセスにより枯渇し、ストレージの反応が遅くなる場合があります。

Ceph において仮想マシンをより効率的に起動するには (一時バックエンドまたはボリュームからの起動)、glance イメージの形式を RAW にする必要があります。

イメージを RAW に変換すると、イメージサイズが元の QCOW2 イメージファイルより大きくなる場合があります。最終的な RAW イメージのサイズを確認するには、変換前に以下のコマンドを実行します。

qemu-img info <image>.qcow2

qemu-img info <image>.qcow2イメージを QCOW2 から RAW 形式に変換するには、以下のコマンドを実行します。

qemu-img convert -p -f qcow2 -O raw <original qcow2 image>.qcow2 <new raw image>.raw

qemu-img convert -p -f qcow2 -O raw <original qcow2 image>.qcow2 <new raw image>.raw1.2.9.1. RAW および ISO だけを受け入れる Image サービスの設定

オプションとして、Image サービスが RAW および ISO イメージ形式だけを受け入れるように設定するには、以下の設定を含む追加の環境ファイルを使用してデプロイを行います。

parameter_defaults:

ExtraConfig:

glance::config::api_config:

image_format/disk_formats:

value: "raw,iso"

parameter_defaults:

ExtraConfig:

glance::config::api_config:

image_format/disk_formats:

value: "raw,iso"1.2.10. RAW 形式でのイメージの保存

以前に作成したイメージを RAW 形式で保存するには、GlanceImageImportPlugins パラメーターを有効にして以下のコマンドを実行します。

-

--name:NAMEをイメージ名に置き換えます。この名前がglance image-listに表示されます。 -

--uri:http://server/image.qcow2を QCOW2 イメージの場所およびファイル名に置き換えます。

このコマンド例では、イメージレコードを作成し、web-download メソッドを使用してそのイメージレコードをインポートします。glance-api は、インポートプロセス中に --uri で定義した場所からイメージをダウンロードします。web-download が利用できない場合、glanceclient はイメージデータを自動的にダウンロードすることができません。利用可能なイメージのインポート方法を一覧表示するには、glance import-info コマンドを実行します。

第2章 Compute (nova) サービスの設定

環境ファイルを使用して Compute (nova) サービスをカスタマイズします。Puppet は、この設定を生成して /var/lib/config-data/puppet-generated/<nova_container>/etc/nova/nova.conf ファイルに保存します。Compute サービスの設定をカスタマイズするには、以下の設定方法を使用します。

Heat パラメーター: 詳細は、『オーバークラウドのパラメーター』の「 Compute(nova) パラメーター」セクションを参照し てください。以下に例を示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Puppet パラメーター:

/etc/puppet/modules/nova/manifests/*で定義されます。parameter_defaults: ComputeExtraConfig: nova::compute::force_raw_images: Trueparameter_defaults: ComputeExtraConfig: nova::compute::force_raw_images: TrueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記この方法は、等価な heat パラメーターが存在しない場合にのみ使用してください。

手動での hieradata の上書き: heat パラメーターまたは Puppet パラメーターが存在しない場合の、パラメーターカスタマイズ用。たとえば、以下の設定により Compute ロールの

[DEFAULT]セクションにdisk_allocation_ratioが定義されます。parameter_defaults: ComputeExtraConfig: nova::config::nova_config: DEFAULT/disk_allocation_ratio: value: '2.0'parameter_defaults: ComputeExtraConfig: nova::config::nova_config: DEFAULT/disk_allocation_ratio: value: '2.0'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

heat パラメーターが存在する場合は、Puppet パラメーターではなくそのパラメーターを使用する必要があります。Puppet パラメーターは存在するが heat パラメーターが存在しない場合は、手動で上書きする方法ではなく Puppet パラメーターを使用する必要があります。手動で上書きする方法は、等価な heat パラメーターまたは Puppet パラメーターがない場合にのみ使用してください。

特定 の設定をカスタマイズする際に heat パラメーターまたは Puppet パラメーターが利用可能かどうかを判断するには、「変更 するパラメーターの特定」のガイダンスに従ってください。

オーバークラウドサービスの設定に関する詳しい情報は、『オーバークラウドの 高度なカスタマイズ』 の「 パラメーター 」を参照してください。

2.1. オーバーコミットのためのメモリー設定

メモリーのオーバーコミットを使用する場合 (NovaRAMAllocationRatio >= 1.0)、割り当て率をサポートするのに十分なスワップ領域を確保してオーバークラウドをデプロイする必要があります。

NovaRAMAllocationRatio パラメーターが 1 より小さい値 に設定されている場合は、RHEL でのスワップサイズの推奨事項に従ってください。詳しくは、RHEL の『ストレージデバイスの管理』の「システムの推奨スワップ領域」を参照してください。

前提条件

- ノードに必要なスワップサイズが計算されている。詳しくは、「スワップサイズの計算」を参照してください。

手順

/usr/share/openstack-tripleo-heat-templates/environments/enable-swap.yamlファイルを環境ファイルのディレクトリーにコピーします。cp /usr/share/openstack-tripleo-heat-templates/environments/enable-swap.yaml /home/stack/templates/enable-swap.yaml

$ cp /usr/share/openstack-tripleo-heat-templates/environments/enable-swap.yaml /home/stack/templates/enable-swap.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のパラメーターを

enable-swap.yamlファイルに追加して、スワップサイズを設定します。parameter_defaults: swap_size_megabytes: <swap size in MB> swap_path: <full path to location of swap, default: /swap>

parameter_defaults: swap_size_megabytes: <swap size in MB> swap_path: <full path to location of swap, default: /swap>Copy to Clipboard Copied! Toggle word wrap Toggle overflow この設定を適用するには、その他の環境ファイルと共に

enable_swap.yaml環境ファイルをスタックに追加し、オーバークラウドをデプロイします。(undercloud) $ openstack overcloud deploy --templates \ -e [your environment files] \ -e /home/stack/templates/enable-swap.yaml \

(undercloud) $ openstack overcloud deploy --templates \ -e [your environment files] \ -e /home/stack/templates/enable-swap.yaml \Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2. コンピュートノード上で確保するホストメモリーの計算

ホストのプロセス用に確保する RAM 容量の合計を判断するには、以下の各項目に十分なメモリーを割り当てる必要があります。

- ノードで実行されるリソース。たとえば、OSD は 3 GB のメモリーを消費します。

- ホスト上のインスタンスを視覚化するのに必要なエミュレーターのオーバーヘッド

- 各インスタンスのハイパーバイザー

メモリーへの追加要求を計算したら、以下の式を使用して各ノードのホストプロセス用に確保するメモリーの容量を決定します。

NovaReservedHostMemory = total_RAM - ( (vm_no * (avg_instance_size + overhead)) + (resource1 * resource_ram) + (resource _n_ * resource_ram))

NovaReservedHostMemory = total_RAM - ( (vm_no * (avg_instance_size + overhead)) + (resource1 * resource_ram) + (resource _n_ * resource_ram))-

vm_noは、インスタンスの数に置き換えてください。 -

avg_instance_sizeは、各インスタンスが使用できるメモリーの平均容量に置き換えてください。 -

overheadは、各インスタンスに必要なハイパーバイザーのオーバーヘッドに置き換えてください。 -

resource1は、ノード上のリソース種別の数に置き換えてください。 -

resource_ramは、この種別の各リソースに必要な RAM の容量に置き換えてください。

2.3. スワップサイズの計算

割り当てるスワップサイズは、メモリーのオーバーコミットを処理するのに十分な容量でなければなりません。以下の式を使用して、ノードに必要なスワップサイズを計算することができます。

-

overcommit_ratio =

NovaRAMAllocationRatio- 1 -

最小スワップサイズ (MB) =

(total_RAM * overcommit_ratio) + RHEL_min_swap -

推奨 (最大) スワップサイズ (MB) =

total_RAM * (overcommit_ratio + percentage_of_RAM_to_use_for_swap)

percentage_of_RAM_to_use_for_swap 変数は、QEMU のオーバーヘッドおよびオペレーティングシステムまたはホストのサービスが消費するその他のリソースに対応するバッファーです。

たとえば、RAM 容量の合計が 64 GB で NovaRAMAllocationRatio が 1 に設定されている場合、利用可能な RAM の 25% をスワップに使用するには、

- 推奨 (最大) スワップサイズ = 64000 MB * (0 + 0.25) = 16000 MB

NovaReservedHostMemory の値を計算する方法は、「コンピュートノード上で確保するホストメモリーの計算」を参照してください。

RHEL_min_swap の値を決定する方法は、RHEL の『ストレージデバイスの管理』の「システムの推奨スワップ領域」を参照してください。

第3章 OpenStack Compute 用のストレージの設定

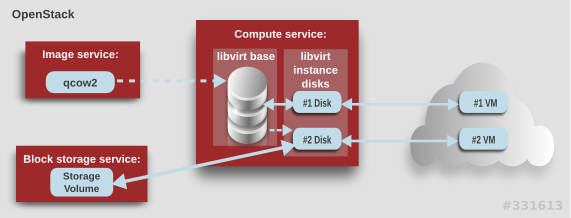

本章では、OpenStack Compute (nova) のイメージのバックエンドストレージのアーキテクチャーについて説明し、基本的な設定オプションを記載します。

3.1. アーキテクチャーの概要

Red Hat OpenStack Platform では、OpenStack Compute サービスは KVM ハイパーバイザーを使用してコンピュートのワークロードを実行します。libvirt ドライバーが KVM とのすべての対話を処理し、仮想マシンが作成できるようにします。

コンピュートには、2 種類の libvirt ストレージを考慮する必要があります。

- Image サービスのイメージのコピーをキャッシュ済み/フォーマット済みのベースイメージ

-

libvirtベースを使用して作成され、仮想マシンインスタンスのバックエンドとなるインスタンスディスク。インスタンスディスクデータは、コンピュートの一時ストレージ (libvirtベースを使用) または永続ストレージ (例: Block Storage を使用) のいずれかに保存されます。

Compute は、以下の手順で仮想マシンインスタンスを作成します。

-

Image サービスのバッキングイメージを

libvirtベースとしてキャッシュします。 - ベースイメージを Raw 形式に変換します (設定されている場合)。

- 仮想マシンのフレーバーの仕様に一致するようにベースイメージのサイズを調節します。

- ベースイメージを使用して libvirt インスタンスディスクを作成します。

上図では、#1 のインスタンスディスクは一時ストレージを使用し、#2 のディスクは Block Storage ボリュームを使用します。

一時ストレージとは、インスタンスで追加で利用可能な、フォーマットされていない空のディスクのことです。このストレージの値は、インスタンスのフレーバーにより定義されます。ユーザーが指定した値は、フレーバーで定義した一時ストレージの値以下でなければなりません。デフォルト値は 0 です。0 を指定すると、一時ストレージが作成されません。

一時ディスクは、外付けのハードドライブや USB ドライブと同じ方法で表示されます。一時ディスクはブロックデバイスとして利用でき、lsblk コマンドを使用して確認することができます。ブロックデバイスとして通常使用するように、フォーマット、マウント、使用が可能です。アタッチ先のインスタンス以外では、このディスクの保存や参照をする方法はありません。

ブロックストレージボリュームは、実行中のインスタンスがどのような状態であっても、インスタンスを利用できる一時ストレージです。

3.2. 設定

Compute (nova) の設定ファイルをカスタマイズして、仮想ディスクのパフォーマンスチューニングおよびセキュリティーを設定することができます。Compute は、『 オーバークラウドのパラメーター』の「 Compute(nova) パラメーター」セクションで説明するパラメーターを使用して、カスタム環境ファイルおよび heat テンプレートで設定します。生成された設定は、/var/lib/config-data/puppet-generated/<nova_container>/etc/nova/nova.conf ファイルに保存されます。詳細を以下の表に示します。

| セクション | パラメーター | 説明 | デフォルト |

|---|---|---|---|

| [DEFAULT] |

|

ベースを Raw に変換すると、ハイパーバイザーが直接使用可能なイメージの容量よりも、容量が多く使用されます (例: qcow2 イメージ)。I/O が遅いシステムや空き容量が少ないシステムを使用している場合は、false に指定して、圧縮の際のCPU 要件を軽減することで入力の帯域幅を最小限に抑えます。

Raw ベースイメージは常に |

|

| [DEFAULT] |

|

| true |

| [DEFAULT] |

|

CoW インスタンスディスクを使用しない場合でも、各仮想マシンが取得するコピーはスパースであるため、仮想マシンが ENOSPC でランタイムに予期せず失敗する可能性があります。インスタンスディスクに | none |

| [DEFAULT] |

|

ブロックデバイス (ブール型) を使用してイメージにアクセスすることで、ベースイメージのサイズを直接調節することができるかどうかを設定します。これは、(それ自体ではサイズ調節ができないため) このパラメーターにより、セキュリティーの関係上、無効にされる可能性のあるイメージを直接マウントできるため、デフォルトでは有効化されていません。 |

|

| [DEFAULT] |

|

新規の一時ボリュームに使用されるデフォルトの形式。値は、 |

|

| [DEFAULT] |

|

libvirt コンピュートノードにキャッシュするベースに影響を与える、イメージキャッシュマネージャーを次に実行するまでの待機時間 (秒数)。この時間は、未使用のキャッシュされたイメージを自動削除する際にも使用されます ( |

|

| [DEFAULT] |

|

未使用のベースイメージを自動的に削除できるようにするかどうかを設定します ( |

|

| [DEFAULT] |

|

未使用となったベースイメージが |

|

|

[ |

|

|

|

第4章 仮想マシンインスタンス

OpenStack Compute は、仮想マシンをオンデマンドで提供する中核的なコンポーネントです。Compute は、認証には Identity サービス、イメージ (インスタンスの起動に使用する) には Image サービス、ユーザー/管理者用のインターフェースには Dashboard サービスと対話します。

Red Hat OpenStack Platform により、クラウド内の仮想マシンインスタンスを容易に管理することができます。Compute サービスはインスタンスの作成、スケジューリング、管理を行い、この機能をその他の OpenStackコンポーネントに公開します。本章では、これらの手順に加えて、キーペア、セキュリティーグループ、ホストアグリゲート、フレーバーなどのコンポーネントを追加する手順について説明します。OpenStack では、インスタンス という用語は、仮想マシンインスタンスの意味で使用されます。

4.1. インスタンスの管理

インスタンスを作成する前には、その他の特定の OpenStack コンポーネント (例: ネットワーク、キーペア、イメージ、ブートソースとなるボリュームなど) をそのインスタンスが利用できる状態にしておく必要があります。

本項では、これらのコンポーネントを追加して、インスタンスを作成/管理する手順について説明します。インスタンスの管理には、更新、ログイン、使用状況の確認、リサイズ、削除などの操作が含まれます。

4.1.1. コンポーネントの追加

以下の各項の手順に従って、ネットワーク、キーペアを作成し、イメージまたはボリュームソースをアップロードします。これらのコンポーネントは、インスタンスの作成に使用され、デフォルトでは提供されません。また、新規セキュリティーグループ作成して、ユーザーが SSH アクセスできるようにする必要があります。

- Dashboard で プロジェクト を選択します。

- ネットワーク & gt; ネットワーク を選択し、新規インスタンスを接続することができるプライベートネットワークが存在していることを確認してください(ネットワークの作成方法については、『ネットワーク ガイド』の「ネットワークの 作成 」セクションを参照してください)。

- コンピュート > アクセスとセキュリティー > キーペア を選択して、キーペアが存在していることを確認します (キーペアの作成方法については、「キーペアの作成」を参照)。

ブートソースに使用可能なイメージまたはボリュームのいずれかがあることを確認してください。

- コンピュート > アクセスとセキュリティー > セキュリティーグループ を選択し、セキュリティーグループルールが作成済みであることを確認します(セキュリティーグループの作成については、『 ユーザーおよびアイデンティティー管理ガイド』の「 プロジェクトのセキュリティー管理 」を参照してください)。

4.1.2. インスタンスの起動

Dashboard から 1 つまたは複数のインスタンスを起動します。

デフォルトでは、インスタンスの起動にはインスタンスの起動フォームが使用されます。ただし、必要なステップを簡単に実行することのできるインスタンスの起動ウィザードを有効にすることも可能です。詳細は、「付録B インスタンスの起動ウィザードの有効化」を参照してください。

- Dashboard で プロジェクト > コンピュート > インスタンス を選択します。

- インスタンスの起動 をクリックします。

- 各フィールド (「*」の付いたフィールドは必須です) に設定値を入力し、起動 をクリックします。

指定したオプションに基づいて、1 つまたは複数のインスタンスが作成され、起動されます。

4.1.2.1. インスタンスの起動オプション

以下の表には、インスタンスの起動フォームを使用して新規インスタンスを起動する際に利用可能なオプションをまとめています。インスタンスの起動ウィザードでも同じオプションが利用できます。

| タブ | フィールド | 説明 |

|---|---|---|

| プロジェクトおよびユーザー | プロジェクト | ドロップダウンリストからプロジェクトを選択します。 |

| ユーザー | ドロップダウンリストからユーザーを選択します。 | |

| 詳細 | アベイラビリティーゾーン | ゾーンとは、インスタンスが配置されるクラウドリソースの論理グループです。不明な場合にはデフォルトのゾーンを使用してください (詳しくは「ホストアグリゲートの管理」を参照)。 |

| インスタンス名 | インスタンスを識別するための名前 | |

| フレーバー | フレーバーは、インスタンスに提供されるリソースを決定します (例: メモリー)。デフォルトのフレーバーの割り当ておよび新規フレーバー作成に関する情報は、「フレーバーの管理」を参照してください。 | |

| インスタンス数 | ここに記載のパラメーターで作成するインスタンスの数。「1」が事前に設定されています。 | |

| インスタンスのブートソース | 選択した項目に応じて異なる新規フィールドが表示され、ソースを選択することができます。

| |

| アクセスとセキュリティー | キーペア | 指定したキーペアがインスタンスに挿入され、SSH を使用したインスタンスへのリモートアクセスに使用されます (直接のログイン情報や静的キーペアが提供されない場合)。通常は 1 プロジェクトあたり 1 つのキーペアが作成されます。 |

| セキュリティーグループ | セキュリティーグループには、インスタンスのネットワークトラフィックの種別と方向をフィルタリングするファイアウォールルールが含まれています(グループの設定についての詳しい説明は、『 ユーザーおよびアイデンティティー 管理ガイド』の「プロジェクトのセキュリティー 管理」を参照してください)。 | |

| ネットワーク | 選択済みネットワーク | ネットワークは、少なくとも 1 つ選択する必要があります。インスタンスは通常プライベートネットワークに割り当てられ、その後に Floating IP アドレスが割り当てられて外部アクセスが可能になります。 |

| 作成後 | カスタマイズスクリプトの入力方法 | インスタンスのブート後に実行されるコマンドセットまたはスクリプトファイルを指定することができます (例: インスタンスのホスト名やユーザーパスワードの設定など)。直接入力 を選択した場合には、スクリプトデータフィールドにコマンドを書き込みます。それ以外の場合には、スクリプトファイルを指定してください。 注記 #cloud-config で開始するスクリプトは、cloud-config 構文を使用するものとして解釈されます (この構文についての情報は、http://cloudinit.readthedocs.org/en/latest/topics/examples.html を参照してください)。 |

| 高度な設定 | ディスクパーティション | デフォルトでは、インスタンスは単一のパーティションとして作成されて、必要に応じて動的にリサイズされます。ただし、パーティションを手動で設定する方法を選択することも可能です。 |

| コンフィグドライブ | このオプションを選択した場合には、OpenStack はメタデータを読み取り専用の設定ドライブに書き込みます。このドライブはインスタンスのブート時に (Compute のメタデータサービスの代わりに) インスタンスに接続されます。インスタンスがブートした後には、このドライブをマウントしてコンテンツを表示することができます (これにより、ユーザーがファイルをインスタンスに提供することが可能となります)。 |

4.1.4. インスタンスのリサイズ

インスタンスのリサイズ (メモリーまたは CPU 数) を行うには、適切な容量のあるインスタンスで新規フレーバーを選択する必要があります。サイズを大きくする場合には、ホストに十分な容量があることをあらかじめ確認することを忘れないようにしてください。

- 各ホストに SSH 鍵認証を設定してホスト間の通信が可能な状態にし、Compute が SSH を使用してディスクを他のホストに移動できるようにします (例: 複数のコンピュートノードが同じ SSH 鍵を共有することが可能です)。

元のホストでリサイズを有効にするには、Compute 環境ファイルの

allow_resize_to_same_hostパラメーターを「True」に設定します。注記allow_resize_to_same_hostパラメーターによって、同じホスト上のインスタンスはリサイズされません。このパラメーターが全コンピュートノードで「True」に指定されている場合でも、スケジューラーは同じホスト上のインスタンスのリサイズを強制しません。これは、想定されている動作です。- Dashboard で プロジェクト > コンピュート > インスタンス を選択します。

- インスタンスの アクション コラムの矢印をクリックして、インスタンスのリサイズ を選択します。

- 新しいフレーバー フィールドで新規フレーバーを選択します。

起動時にインスタンスのパーティション分割を手動で行うには、以下の手順で設定します (これにより、ビルドタイムが短縮されます)。

- 高度な設定 を選択します。

- ディスクパーティション フィールドで、手動 を選択します。

- リサイズ をクリックします。

4.1.5. インスタンスへの接続

本項では、Dashboard またはコマンドラインインターフェースを使用して、インスタンスのコンソールにアクセスする複数の方法について説明します。また、インスタンスのシリアルポートに直接接続して、ネットワーク接続が失敗しても、デバッグすることが可能です。

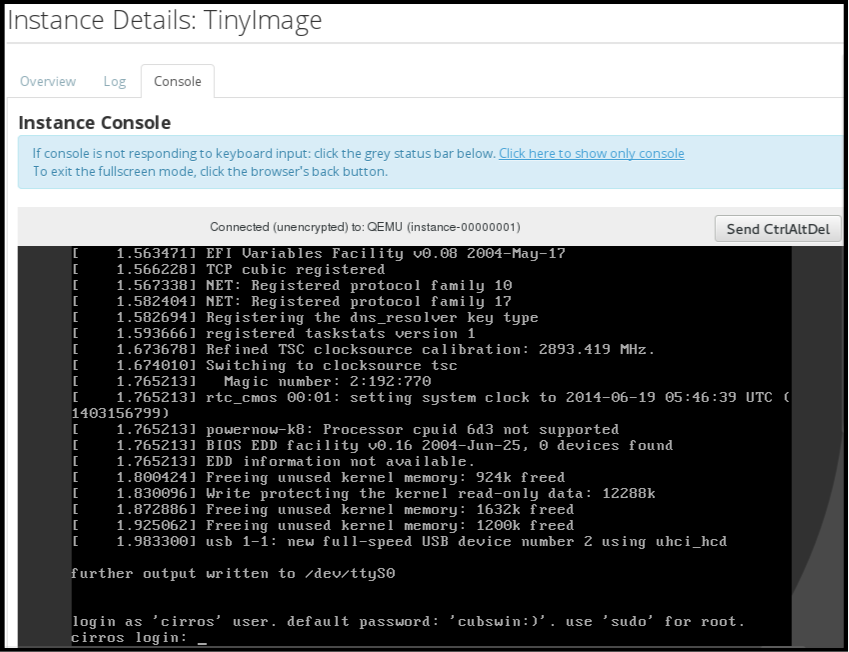

4.1.5.1. Dashboard を使用したインスタンスのコンソールへのアクセス

コンソールを使用すると、Dashboard 内でインスタンスに直接アクセスすることができます。

- Dashboard で コンピュート > インスタンス を選択します。

-

インスタンスの ドロップダウンメニュー をクリックして、コンソール を選択します。

- イメージのユーザー名とパスワードを使用してログインします (例: CirrOS イメージでは「cirros」と「cubswin:)」を使用します)。

4.1.5.2. VNC コンソールへの直接接続

nova get-vnc-console コマンドで返された URL を使用すると、インスタンスの VNC コンソールに直接アクセスすることができます。

- ブラウザー

ブラウザーの URL を取得するには、以下のコマンドを実行します。

nova get-vnc-console INSTANCE_ID novnc

$ nova get-vnc-console INSTANCE_ID novncCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Java クライアント

Java クライアントの URL を取得するには、以下のコマンドを実行します。

nova get-vnc-console INSTANCE_ID xvpvnc

$ nova get-vnc-console INSTANCE_ID xvpvncCopy to Clipboard Copied! Toggle word wrap Toggle overflow

「nova-xvpvncviewer」は、Java クライアントの最も簡単な例を提供します。クライアントをダウンロードするには、以下のコマンドを実行します。

git clone https://github.com/cloudbuilders/nova-xvpvncviewer cd nova-xvpvncviewer/viewer make

# git clone https://github.com/cloudbuilders/nova-xvpvncviewer

# cd nova-xvpvncviewer/viewer

# makeインスタンスの Java クライアント URL を使用してビューアーを実行します。

java -jar VncViewer.jar URL

# java -jar VncViewer.jar URLこのツールは、お客様の便宜のためのみに提供されており、Red Hat では正式にサポートされていません。

4.1.6. インスタンスの使用状況の表示

以下のような使用状況統計が提供されます。

プロジェクト別

プロジェクト別の使用状況を確認するには、プロジェクト > コンピュート > 概要 を選択します。全プロジェクトインスタンスの使用状況の概要が即時に表示されます。

使用状況を照会する期間を指定して 送信 ボタンをクリックすると、特定の期間の統計を表示することもできます。

ハイパーバイザー別

管理者としてログインしている場合には、全プロジェクトの情報を表示することができます。管理 > システム をクリックしてからタブを 1 つ選択します。たとえば、リソース使用状況 タブでは、特定の期間のレポートを確認することができます。また、ハイパーバイザー をクリックすると、現在の仮想 CPU、メモリー、ディスクの統計を確認することができます。

注記仮想 CPU 使用量の値 (y 中 x 使用中) には、全仮想マシンの仮想 CPU の合計数 (x) とハイパーバイザーのコアの合計数 (y) が反映されます。

4.1.7. インスタンスの削除

- Dashboard で プロジェクト > コンピュート > インスタンス を選択して、対象のインスタンスにチェックを付けます。

- インスタンスの削除 をクリックします。

インスタンスを削除しても、接続されていたボリュームは削除されません。この操作は別途実行する必要があります(『 ストレージガイド』の「ボリュームの 削除 」を参照)。

4.1.8. 複数インスタンスの同時管理

同時に複数のインスタンスを起動する必要がある場合には (例: コンピュートまたはコントローラーのメンテナンスでダウンしている場合など)、プロジェクト > コンピュート > インスタンス から簡単に起動できます。

- 起動するインスタンスの最初のコラムにあるチェックボックスをクリックします。全インスタンスを選択するには、表の最初の行のチェックボックスをクリックします。

- 表の上にある その他のアクション をクリックして インスタンスの起動 を選択します。

同様に、適切なアクションを選択して、複数のインスタンスを終了またはソフトリブートすることができます。

4.2. インスタンスのセキュリティーの管理

適切なセキュリティーグループ (ファイアウォールのルールセット) およびキーペア (SSH を介したユーザーのアクセスの有効化) を割り当てることによってインスタンスへのアクセスを管理することができます。また、インスタンスに Floating IP アドレスを割り当てて外部ネットワークへのアクセスを有効にすることができます。以下の各項では、キーペア、セキュリティーグループ、Floating IP アドレスの作成/管理方法と SSH を使用したログインの方法について説明します。また、インスタンスに admin パスワードを挿入する手順についても記載しています。

セキュリティーグループの管理に関する情報は、『 ユーザーおよびアイデンティティー 管理ガイド』の「プロジェクト のセキュリティー管理」を 参照してください。

4.2.1. キーペアの管理

キーペアにより、インスタンスへ SSH でアクセスすることができます。キーペアの生成時には毎回、証明書がローカルマシンにダウンロードされ、ユーザーに配布できます。通常は、プロジェクトごとにキーペアが 1 つ作成されます (そのキーペアは、複数のインスタンスに使用されます)。

既存のキーペアを OpenStack にインポートすることも可能です。

4.2.1.1. キーペアの作成

- Dashboard で プロジェクト > コンピュート > アクセスとセキュリティー を選択します。

- キーペア タブで キーペアの作成 をクリックします。

- キーペア名 フィールドに名前を指定し、キーペアの作成 をクリックします。

キーペアが作成されると、ブラウザーを介してキーペアファイルが自動的にダウンロードされます。後ほど外部のマシンから接続できるように、このファイルを保存します。また、コマンドラインの SSH 接続には、以下のコマンドを実行して、このファイルを SSH にロードすることができます。

ssh-add ~/.ssh/os-key.pem

# ssh-add ~/.ssh/os-key.pem4.2.1.2. キーペアのインポート

- Dashboard で プロジェクト > コンピュート > アクセスとセキュリティー を選択します。

- キーペア タブで キーペアのインポート をクリックします。

- キーペア名 のフィールドに名前を指定し、公開鍵の内容をコピーして、公開鍵 のフィールドにペーストします。

- キーペアのインポート をクリックします。

4.2.1.3. キーペアの削除

- Dashboard で プロジェクト > コンピュート > アクセスとセキュリティー を選択します。

- キーペア タブでそのキーの キーペアの削除 ボタンをクリックします。

4.2.2. セキュリティーグループの作成

セキュリティーグループとは、プロジェクトのインスタンスに割り当て可能な IP フィルターのルールセットで、インスタンスへのネットワークのアクセス権限を定義します。セキュリティーグループはプロジェクト別になっており、プロジェクトメンバーは自分のセキュリティーグループのデフォルトルールを編集して新規ルールセットを追加することができます。

- Dashboard で プロジェクト タブを選択して、コンピュート > アクセスとセキュリティー をクリックします。

- セキュリティーグループ タブで、+ セキュリティーグループの作成 をクリックします。

- セキュリティーグループに名前と説明を指定して、セキュリティーグループの作成 をクリックします。

プロジェクトセキュリティーの管理に関する情報は、『 ユーザーおよびアイデンティティー 管理 ガイド』の「プロジェクトのセキュリティー管理」を参照 してください。

4.2.3. Floating IP アドレスの作成、割り当て、および解放

デフォルトでは、インスタンスを最初に作成する際に、そのインスタンスに内部 IP アドレスが割り当てられます。ただし、Floating IP アドレス (外部アドレス) を作成して割り当てることによりパブリックネットワークを介したアクセスを有効にすることができます。インスタンスに割り当てられている IP アドレスは、インスタンスの状態に関わらず変更することができます。

プロジェクトには、使用できる Floating IP アドレスの範囲が限定されているので (デフォルトの上限は 50)、必要がなくなったアドレスは、再利用できるように解放することを推奨します。Floating IP アドレスは、既存の Floating IP プールからのみ確保することができます。『ネットワークガイド』 の「 Floating IP アドレスプールの作成 」を参照してください。

4.2.3.1. プロジェクトへの Floating IP アドレスの確保

- Dashboard で プロジェクト > コンピュート > アクセスとセキュリティー を選択します。

- Floating IP タブで Floating IP の確保 をクリックします。

- プール のフィールドで、IP アドレスを確保するネットワークを選択します。

- IP の確保 をクリックします。

4.2.3.2. Floating IP の割り当て

- Dashboard で プロジェクト > コンピュート > アクセスとセキュリティー を選択します。

- Floating IP タブでアドレスの 割り当て ボタンをクリックします。

IP アドレスフィールドで割り当てるアドレスを選択します。

注記割り当てることのできるアドレスがない場合には、

+ボタンをクリックして新規アドレスを作成することができます。- IP を割り当てるポート フィールドで割り当て先となるインスタンスを選択します。1 つのインスタンスに割り当てることができる Floating IP アドレスは 1 つのみです。

- 割り当て をクリックします。

4.2.3.3. Floating IP の解放

- Dashboard で プロジェクト > コンピュート > アクセスとセキュリティー を選択します。

- Floating IP タブで、アドレスの 割り当て/割り当て解除 ボタンの横にある矢印メニューをクリックします。

- Floating IP の解放 を選択します。

4.2.4. インスタンスへのログイン

前提条件

- インスタンスのセキュリティーグループには SSH ルールが設定されているようにしてください(『 ユーザーおよびアイデンティティー 管理ガイド』の「プロジェクト のセキュリティー管理」を参照してください)。

- インスタンスに Floating IP アドレス (外部アドレス) が割り当てられていることを確認します (「Floating IP アドレスの作成、割り当て、および解放」を参照)。

- インスタンスのキーペアの証明書を取得します。証明書は、キーペアの作成時にダウンロードされます。キーペアを自分で作成しなかった場合には、管理者に問い合わせてください (「キーペアの管理」を参照)。

最初に、キーペアのファイルを SSH に読み込み、次に名前を指定せずに ssh を使用します。

生成したキーペアの証明書のアクセス権を変更します。

chmod 600 os-key.pem

$ chmod 600 os-key.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow ssh-agentがすでに実行されているかどうかを確認します。ps -ef | grep ssh-agent

# ps -ef | grep ssh-agentCopy to Clipboard Copied! Toggle word wrap Toggle overflow 実行されていない場合には、次のコマンドで起動します。

eval `ssh-agent`

# eval `ssh-agent`Copy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルマシンで、キーペアの証明書を SSH に読み込みます。以下に例を示します。

ssh-add ~/.ssh/os-key.pem

$ ssh-add ~/.ssh/os-key.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow - これで、イメージにより提供されるユーザーで、ファイルに SSH アクセスできるようになりました。

以下のコマンドの例は、Red Hat Enterprise Linux のゲストイメージに cloud-user として SSH アクセスする方法を示しています。

ssh cloud-user@192.0.2.24

$ ssh cloud-user@192.0.2.24証明書を直接使用することも可能です。以下に例を示します。

ssh -i /myDir/os-key.pem cloud-user@192.0.2.24

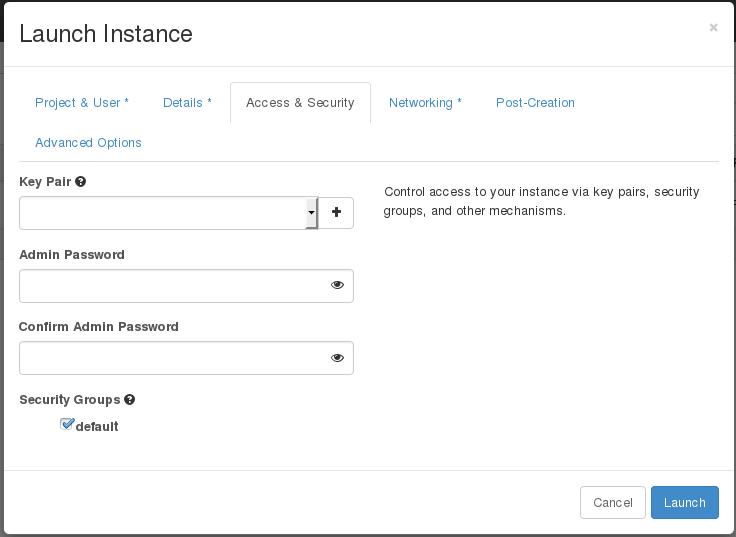

$ ssh -i /myDir/os-key.pem cloud-user@192.0.2.244.2.5. インスタンスへの admin パスワード挿入

以下の手順に従って、admin (root) パスワードを挿入することができます。

/etc/openstack-dashboard/local_settingsファイルで、change_set_passwordパラメーターの値をTrueに設定します。can_set_password: True

can_set_password: TrueCopy to Clipboard Copied! Toggle word wrap Toggle overflow Compute 環境ファイルの

inject_passwordパラメーターを「True」に設定します。inject_password=true

inject_password=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow Compute サービスを再起動します。

service nova-compute restart

# service nova-compute restartCopy to Clipboard Copied! Toggle word wrap Toggle overflow

nova boot コマンドを使用して、新規インスタンスを起動する際には、コマンドの出力に adminPass パラメーターが表示されます。このパスワードを使用して、インスタンスに root ユーザーとしてログインすることができます。

Compute サービスは、/etc/shadow ファイル内のパスワード値を root ユーザー用に上書きします。以下の手順は、KVM ゲストイメージの root アカウントをアクティブ化するのにも使用することが可能です。KVM ゲストイメージの使用方法についての詳しい情報は、「Red Hat OpenStack Platform における KVM ゲストイメージの使用」を参照してください。

Dashboard からカスタムパスワードを設定することも可能です。これを有効にするには、can_set_password パラメーターを true に設定した後に、以下のコマンドを実行します。

systemctl restart httpd.service

# systemctl restart httpd.service

新規追加された admin パスワードフィールドは以下のように表示されます。

上記のフィールドは、インスタンスの起動/再ビルド時に使用することができます。

4.3. フレーバーの管理

作成する各インスタンスには、インスタンスのサイズや容量を決定するためのフレーバー (リソースのテンプレート) を指定します。また、フレーバーを使用して、セカンダリー一時ストレージやスワップディスク、使用率を制限するためのメタデータ、特別なプロジェクトへのアクセスを指定することも可能です (デフォルトのフレーバーにはこのような追加の属性は一切定義されていません)。

| 名前 | 仮想 CPU の数 | メモリー | ルートディスクのサイズ |

|---|---|---|---|

| m1.tiny | 1 | 512 MB | 1 GB |

| m1.small | 1 | 2048 MB | 20 GB |

| m1.medium | 2 | 4096 MB | 40 GB |

| m1.large | 4 | 8192 MB | 80 GB |

| m1.xlarge | 8 | 16384 MB | 160 GB |

エンドユーザーの大半は、デフォルトのフレーバーを使用できます。ただし、特化したフレーバーを作成/管理することができます。たとえば、以下の操作を行うことができます。

- 基になるハードウェアの要件に応じて、デフォルトのメモリーと容量を変更する

- インスタンスに特定の I/O レートを強制するためのメタデータ、またはホストアグリゲートと一致させるためのメターデータを追加する

イメージのプロパティーを使用して設定した動作は、フレーバーを使用して設定した動作よりも優先されます。詳しい説明は、「イメージの管理」を参照してください。

4.3.1. 設定パーミッションの更新

デフォルトでは、フレーバーの作成およびフレーバーの完全リストの表示ができるのは管理者のみです (「管理 > システム > フレーバー」を選択)。全ユーザーがフレーバーを設定できるようにするには、/etc/nova/policy.json ファイル (nova-api サーバー) で以下の値を指定します。

"compute_extension:flavormanage": "",

4.3.2. フレーバーの作成

- Dashboard に管理ユーザーとしてログインして 管理 > システム > フレーバー を選択します。

フレーバーの作成 をクリックして、以下のフィールドに入力します。

Expand 表4.4 フレーバーのオプション タブ フィールド 説明 フレーバー情報

名前

一意な名前

ID

一意な ID。デフォルト値は

autoで、UUID4 値を生成しますが、整数または UUID4 値 を手動で指定することもできます。仮想 CPU

仮想 CPU 数

メモリー (MB)

メモリー (メガバイト単位)

ルートディスク (GB)

一時ディスクのサイズ (ギガバイト単位)。ネイティブイメージサイズを使用するには

0を指定します。このディスクは、Instance Boot Source=Boot from Volume と指定されている場合には使用されません。一時ディスク (GB)

インスタンスで利用可能なセカンダリー一時ディスクのサイズ (ギガバイト単位)。このディスクは、インスタンスの削除時に破棄されます。

デフォルト値は

0です。この値を指定すると、一時ディスクは作成されません。スワップディスク (MB)

スワップディスクのサイズ (メガバイト単位)

フレーバーアクセス権

選択済みのプロジェクト

そのフレーバーを使用することができるプロジェクト。プロジェクトが選択されていない場合には、全プロジェクトにアクセスが提供されます (

Public=Yes)。- フレーバーの作成 をクリックします。

4.3.3. 一般属性の更新

- Dashboard に管理ユーザーとしてログインして 管理 > システム > フレーバー を選択します。

- 対象のフレーバーの フレーバーの編集 ボタンをクリックします。

- 値を更新して、保存 をクリックします。

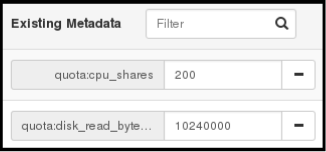

4.3.4. フレーバーのメタデータの更新

一般属性の編集に加えて、フレーバーにメタデータ (extra_specs) を追加することが可能です。メタデータは、インスタンスの使用方法を微調整するのに役立ちます。たとえば、最大許容帯域幅やディスクの書き込みを設定する場合などです。

- 事前定義済みのキーにより、ハードウェアサポートやクォータが決定されます。事前定義済みのキーは、使用するハイパーバイザーによって限定されます (libvirt の場合は 表4.5「Libvirt のメタデータ」を参照してください)。

-

事前定義済みおよびユーザー定義のキーはいずれも、インスタンスのスケジューリングを決定します。たとえば、

SpecialComp=Trueと指定すると、このフレーバーを使用するインスタンスはすべてメタデータのキーと値の組み合わせが同じホストアグリゲートでのみ実行可能となります (「ホストアグリゲートの管理」を参照)。

4.3.4.1. メタデータの表示

- Dashboard に管理ユーザーとしてログインして 管理 > システム > フレーバー を選択します。

-

フレーバーの メタデータ リンク (

はいまたはいいえ) をクリックします。現在の値はすべて右側の 選択済みのメタデータ の下に一覧表示されます。

4.3.4.2. メタデータの追加

キーと値 のペアを使用してフレーバーのメタデータを指定します。

- Dashboard に管理ユーザーとしてログインして 管理 > システム > フレーバー を選択します。

-

フレーバーの メタデータ リンク (

はいまたはいいえ) をクリックします。現在の値はすべて右側の 選択済みのメタデータ の下に一覧表示されます。 - 利用可能なメタデータ で その他 のフィールドをクリックして、追加するキーを指定します (表4.5「Libvirt のメタデータ」を参照)。

- 「+」ボタンをクリックします。選択済みのメタデータ の下に新しいキーが表示されるようになりました。

右側のフィールドにキーの値を入力します。

- キーと値のペアの追加が終了したら 保存 をクリックします。

| キー | 説明 |

|---|---|

|

| インスタンスごとにサポート制限を設定するアクション。有効なアクションは以下のとおりです。

例: |

|

| インスタンスの NUMA トポロジーの定義。RAM および仮想 CPU の割り当てがコンピュートホスト内の NUMA ノードのサイズよりも大きいフレーバーの場合には、NUMA トポロジーを定義することでホストが NUMA を効果的に使用してゲスト OS のパフォーマンスを向上することができます。フレーバーで定義された NUMA の定義は、イメージの定義をオーバーライドします。有効な定義は以下のとおりです。

注記

インスタンスに 8 個の仮想 CPU、4 GB の RAM が指定されている場合の例:

スケジューラーは、NUMA ノードが 2 つあり、そのうちの 1 つのノードで 6 つの CPU および 3072 MB または 3 GB のメモリーを実行し、別のノードで 2 つの CPU および 1024 MB または 1 GB のメモリーを実行できるホストを検索します。ホストに 8 つの CPU および 4 GB のメモリーを実行できる NUMA ノードが 1 つある場合は、有効な一致とは見なされません。 |

|

| インスタンスのウォッチドッグデバイスを使用して、インスタンスに何らかの理由でエラー (またはハング) が発生した場合にアクションをトリガーすることができます。有効なアクションは以下のとおりです。

例: |

|

| このパラメーターを使用して、PCI パススルーデバイスおよび SR-IOV インターフェースの NUMA アフィニティーポリシーを指定することができます。以下の有効な値のいずれかに設定します。

例: |

|

|

イメージプロパティーを使用して乱数生成器をインスタンスに追加することができます (Red Hat OpenStack Platform ドキュメントの『Command-Line Interface Reference』で このデバイスを追加した場合の有効なアクションは以下のとおりです。

例: |

|

| ビデオデバイスの最大許容 RAM (MB 単位)

例: |

|

| インスタンスの制限を強制します。有効なオプションは以下のとおりです。

例: さらに、VMware ドライバーは、CPU、メモリー、ディスク、ネットワークの上限、下限を制御する以下のクォータオプションや、プロジェクトで利用可能なリソースの相対割り当てを制御するのに使用可能な 共有 をサポートします。

|

4.4. ホストアグリゲートの管理

パフォーマンスおよび管理目的で、単一の Compute デプロイメントを複数の論理グループにパーティショニングすることができます。OpenStack では以下のような用語を使用しています。

ホストアグリゲート: ホストアグリゲートは、ホストをグループ化してまとめることによって OpenStack デプロイメント内に論理ユニットを作成します。アグリゲートは、割り当てられた Compute ホストと関連付けられたメタデータです。1 台のホストは複数のアグリゲートに属することが可能です。ホストアグリゲートの表示と作成ができるのは管理者のみです。

アグリゲートのメタデータは通常、Compute のスケジューラーで使用する情報を提供します (例: 特定のフレーバーやイメージを複数のホストの 1 つのサブネットに制限するなど)。ホストアグリゲートで指定されるメタデータは、フレーバー内で同じメタデータが指定されているインスタンスにホストの使用を限定します。

管理者は、ホストアグリゲートを使用して、ロードバランスの処理、物理的な分離 (または冗長) の強制、共通の属性を持つサーバーのグループ化、ハードウェアクラスの分類などを行うことができます。アグリゲートの作成時には、ゾーン名を指定する必要があります。この名前がエンドユーザーに表示されます。

アベイラビリティーゾーン: アベイラビリティーゾーンとは、ホストアグリゲートのエンドユーザーのビューです。エンドユーザーはゾーンがどのホストで構成されているかを表示したり、ゾーンのメタデータを確認したりすることはできません。ユーザーが見ることができるのはゾーン名のみです。

一定の機能や一定のエリア内で設定された特定のゾーンを使用するようにエンドユーザーを誘導することができます。

4.4.1. ホストアグリゲートのスケジューリングの有効化

デフォルトでは、ホストアグリゲートのメタデータは、インスタンスの使用先のフィルタリングには使用されません。メタデータの使用を有効にするには、Compute のスケジューラーの設定を更新する必要があります。

- Compute 環境ファイルを開きます。

NovaSchedulerDefaultFiltersパラメーターにまだ以下の値がなければ、値を追加します。ホストアグリゲートのメタデータ用の

AggregateInstanceExtraSpecsFilter注記同じ

NovaSchedulerDefaultFiltersパラメーターの値としてAggregateInstanceExtraSpecsFilterおよびComputeCapabilitiesFilterフィルターの両方を指定する場合には、フレーバーextra_specsの設定にスコープを定義した仕様を使用する必要があります。使用しない場合には、ComputeCapabilitiesFilterは適切なホストの選択に失敗します。これらのフィルター用にフレーバーextra_specsキーのスコープを定義するのに使用する名前空間の詳細は、表4.7「スケジューリングフィルター」 を参照してください。-

インスタンス起動時のアベイラビリティーゾーンのホスト仕様用の

AvailabilityZoneFilter

- 設定ファイルを保存します。

- オーバークラウドをデプロイします。

4.4.2. アベイラビリティーゾーンまたはホストアグリゲートの表示

Dashboard に管理ユーザーとしてログインして 管理 > システム > ホストアグリゲート を選択します。ホストアグリゲート のセクションに現在定義済みのアグリゲートがすべてリストされます。アベイラビリティーゾーン のセクションには全ゾーンがリストされます。

4.4.3. ホストアグリゲートの追加

- Dashboard に管理ユーザーとしてログインして 管理 > システム > ホストアグリゲート を選択します。ホストアグリゲート のセクションに現在定義済みのアグリゲートがすべてリストされます。

- ホストアグリゲートの作成 をクリックします。

- 名前 フィールドにアグリゲートの名前を入力します。この名前が アベイラビリティーゾーン フィールドでエンドユーザーに表示されます。

- アグリゲートのホストの管理 をクリックします。

- 「+」アイコンをクリックしてホストを選択します。

- ホストアグリゲートの作成 をクリックします。

4.4.4. ホストアグリゲートの更新

- Dashboard に管理ユーザーとしてログインして 管理 > システム > ホストアグリゲート を選択します。ホストアグリゲート のセクションに現在定義済みのアグリゲートがすべてリストされます。

インスタンスの 名前 または アベイラビリティーゾーン を更新するには、以下の手順で行います。

- アグリゲートの ホストアグリゲートの編集 ボタンをクリックします。

- 名前 または アベイラビリティーゾーン のフィールドを更新して、保存 をクリックします。

インスタンスの 割り当て済みのホスト を更新するには、以下の手順で行います。

- アクション の下にあるアグリゲートの矢印アイコンをクリックします。

- ホストの管理 をクリックします。

- 「+」または「-」のアイコンをクリックしてホストの割り当てを変更します。

- 終了したら、保存 をクリックします。

インスタンスの メタデータ を更新するには、以下の手順で行います。

- アクション の下にあるアグリゲートの矢印アイコンをクリックします。

- メタデータの更新 ボタンをクリックします。現在の値はすべて右側の 選択済みのメタデータ の下に一覧表示されます。

- 利用可能なメタデータ で その他 のフィールドをクリックして、追加するキーを指定します。事前に定義したキー (表4.6「ホストアグリゲートのメタデータ」を参照) を使用するか、独自のキーを追加します (このキーと全く同じキーがインスタンスのフレーバーに設定されている場合にのみ有効となります)。

「+」ボタンをクリックします。選択済みのメタデータ の下に新しいキーが表示されるようになりました。

注記キーを削除するには、「-」のアイコンをクリックします。

保存 をクリックします。

Expand 表4.6 ホストアグリゲートのメタデータ キー 説明 filter_project_idこれが指定されている場合、アグリゲートはこのプロジェクト(テナント)のみをホストします。これは、Compute のスケジューラーに設定されている

AggregateMultiTenancyIsolationフィルターによって異なります。

4.4.5. ホストアグリゲートの削除

- Dashboard に管理ユーザーとしてログインして 管理 > システム > ホストアグリゲート を選択します。ホストアグリゲート のセクションに現在定義済みのアグリゲートがすべてリストされます。

割り当てられている全ホストをアグリゲートから削除します。

- アクション の下にあるアグリゲートの矢印アイコンをクリックします。

- ホストの管理 をクリックします。

- 「-」アイコンをクリックして、全ホストを削除します。

- 終了したら、保存 をクリックします。

- アクション の下にあるアグリゲートの矢印アイコンをクリックします。

- このダイアログ画面と次の画面で ホストアグリゲートの削除 をクリックします。

4.5. ホストのスケジュール

Compute のスケジューリングサービスは、インスタンスの配置先となるホストまたはホストアグリゲートを決定します。管理者は、設定を使用して、スケジューラーによるインスタンスの配置先の決定方法を定義することができます。たとえば、特定のグループや適切な量の RAM があるホストにスケジューリングを限定することが可能です。

以下のコンポーネントを設定することができます。

- フィルター: インスタンスの配置先候補となるホストの初期セットを決定します (「スケジューリングフィルターの設定」を参照)。

- 重み: フィルタリングの完了時に選出されたホストのセットは重み付けのシステムを使用して優先順位が決定されます。最も高い重みが最優先されます (「スケジューリングの重みの設定」を参照)。

-

スケジューラーサービス: スケジューラーホスト上の

/var/lib/config-data/puppet-generated/<nova_container>/etc/nova/nova.confファイルには数多くの設定オプションがあります。これらのオプションは、スケジューラーがタスクを実行する方法や、重み/フィルターを処理する方法を決定します。 - Placement サービス: ストレージディスクの種別や Intel CPU 拡張命令セットなど、インスタンスがホストに必要な特性を指定します( 「Placement サービスの特性の設定」を参照)。

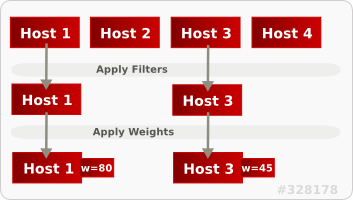

下図では、フィルタリング後には Host 1 と Host 3 の両方が条件に適合しています。Host 1 の重みが最も高いため、スケジューリングで最優先されます。

4.5.1. スケジューリングフィルターの設定

スケジューラーが使用するフィルターを定義するには、Compute 環境ファイルの NovaSchedulerDefaultFilters パラメーターを使用します。フィルタを追加したり削除したりすることができます。

デフォルト設定では、スケジューラーで以下のフィルターが実行されます。

- RetryFilter

- AvailabilityZoneFilter

- ComputeFilter

- ComputeCapabilitiesFilter

- ImagePropertiesFilter

- ServerGroupAntiAffinityFilter

- ServerGroupAffinityFilter

一部のフィルターは、以下の方法でインスタンスに渡されるパラメーターの情報を使用します。

-

nova bootコマンド - インスタンスのフレーバー (「フレーバーのメタデータの更新」を参照)

- インスタンスのイメージ (「付録A イメージの設定パラメーター」を参照)

利用可能なすべてのフィルターを一覧にして以下の表に示します。

| フィルター | 説明 |

|---|---|

|

| インスタンスのイメージのメタデータが一致するホストアグリゲート内のホストのみを渡します。これは、そのインスタンスにホストアグリゲートが指定されている場合にのみ有効です。詳細は、「「イメージの作成」」を参照してください。 |

|

| ホストアグリゲート内のメタデータは、ホストのフレーバーのメタデータと一致する必要があります。詳細は、「「フレーバーのメタデータの更新」」を参照してください。 |

|

このフィルターを

| |

|

|

注記 プロジェクトが他のホストにインスタンスを配置することは可能です。 |

|

| 利用可能な全ホストを渡します (ただし、他のフィルターは無効化しません)。 |

|

| インスタンスに指定されているアベイラビリティーゾーンを使用してフィルタリングします。 |

|

|

Compute のメタデータが正しく読み取られるようにします。「 |

|

| 稼働中の有効なホストのみを渡します。 |

|

|

指定されている単一または複数のホストとは別のホスト上でインスタンスをビルドできるようにします。 |

|

| インスタンスのイメージプロパティーに一致するホストのみを渡します。詳細は、「「イメージの作成」」を参照してください。 |

|

|

|

|

| インスタンスのカスタム JSON フィルターを認識/使用します。

|

|

このフィルターは、クエリーヒントとして

| |

|

| メトリックが利用できないホストを除外します。 |

|

| NUMA トポロジーに基づいてホストを除外します。インスタンスにトポロジーが未定義の場合には、任意のホストを使用することができます。このフィルターは、NUMA トポロジーが完全に同じインスタンスとホストをマッチングするように試みます (そのホスト上ではインスタンスのスケジューリングは試みません)。また、このフィルターは、NUMA ノードの標準的なオーバーサブスクリプションの上限を確認し、それに応じて、コンピュートホストに対して制限を指定します。 |

|

| 重み付け関数はホスト上の PCI デバイスの数とインスタンスに要求された PCI デバイス数に基づいて重みを計算することができます。たとえば、ホストが 3 台利用可能で、PCI デバイスが 1 つのホストが 1 台、複数の PCI デバイスがあるホストが 1 台、PCI デバイスがないホストが 1 台の場合には、Compute はインスタンスの需要に基づいてこれらのホストの優先順位付けを行う必要があります。インスタンスが PCI デバイスを 1 つ要求している場合には 1 番目のホスト、複数の PCI デバイスを要求している場合には 2 番目のホスト、PCI デバイスを要求していない場合には 3 番目のホストが優先されるべきです。 詳しくは、「PCI デバイスがアタッチされている NUMA ノードの確保」を参照してください。 |

|

|

スケジュールを試みて失敗したホストを除外します。 |

|

|

指定されている単一または複数のホストを渡します。 |

|

| 特定のサーバーグループのホストのみを渡します。

|

|

| インスタンスをまだホストしていないサーバーグループ内のホストのみを渡します。

|

|

|

インスタンスの cidr および

|

4.5.2. スケジューリングの重みの設定

ホストは、スケジューリング用に重み付けすることができます。(フィルタリング後に) 重みが最大のホストが選択されます。重み付け関数にはすべて、ノードの重みを正規化した後に適用される乗数が指定されます。ノードの重みは以下のように計算されます。

w1_multiplier * norm(w1) + w2_multiplier * norm(w2) + ...

w1_multiplier * norm(w1) + w2_multiplier * norm(w2) + ...重みのオプションは、コンピュートノードの設定ファイルで定義することができます。

4.5.2.1. ホストの重みのオプション設定

スケジューラーが使用するホストの重み付け関数は、[DEFAULT] scheduler_weight_classes のオプションで定義することができます。有効な重み付け関数は以下のとおりです。

-

nova.scheduler.weights.ram: ホストの使用可能なメモリーを重み付けします。 -

nova.scheduler.weights.metrics: ホストのメトリックを重み付けします。 -

nova.scheduler.weights.affinity: 特定のサーバーグループ内にある他のホストとのホストの近接性を重み付けします。 -

nova.scheduler.weights.all_weighers: 全ホストの重み付け関数を使用します (デフォルト)。

| 重み付け関数 | オプション | 説明 |

|---|---|---|

| すべて |

[DEFAULT] |

ホストの選択先のサブセットサイズを定義します (整数)。 |

| affinity |

[default] |

グループソフトアフィニティーのホストを重み付けする際に使用します。正の浮動小数点数を指定してください。これは、負の値を指定すると反対の動作が発生してしまうためです。通常、このような反対の動作は、 |

| affinity |

[default] |

グループソフト非アフィニティーのホストを重み付けする際に使用します。正の浮動小数点数を指定してください。これは、負の値を指定すると反対の動作が発生してしまうためです。通常、このような反対の動作は、 |

| metrics |

[metrics] |

[metrics]

|

| metrics |

[metrics] |

[metrics] |

| metrics |

[metrics] |

メトリックを重み付けする乗数。デフォルトでは |

| metrics |

[metrics] |

重み付けに使用されるメトリックと比率を指定します。

例: |

| ram |

[DEFAULT] |

RAM の乗数 (浮動小数点)。デフォルトでは、 |

4.5.3. Placement サービスの特性の設定

Placement サービスは、コンピュートノード、共有ストレージプール、または IP 割り当てプールなど、リソースプロバイダーのインベントリーおよび使用状況を追跡します。リソースの選択および消費を管理する必要があるサービスは、すべて Placement サービスを使用することができます。

Placement サービスにクエリーを行うには、アンダークラウドに python3-osc-placement パッケージをインストールします。

各リソースプロバイダーには特性のセットがあります。特性は、ストレージディスクの種別や Intel CPU 拡張命令セットなど、リソースプロバイダーの機能的な要素です。インスタンスは、これらの中から要求する特性を指定することができます。

Compute (nova) サービスは、nova-compute および nova-scheduler プロセスを使用して Placement サービスと協調してインスタンスを作成します。

nova-compute- リソースプロバイダーレコードを作成します。

- 利用可能な仮想 CPU の数など、利用可能なリソースを数量的に記述するインベントリーを設定します。

-

リソースプロバイダーの性質的な要素を記述する特性を設定します。

libvirt仮想化ドライバーは、これらの特性を Placement サービスに報告します(詳しくは 「Placement サービスの特性としてのlibvirt仮想化ドライバー機能」 を参照)。

nova-scheduler- Placement サービスに、割り当て候補の一覧を要求します。

- インスタンスが要求する特性に基づいて、サーバーの構築先となるホストを決定します。

4.5.3.1. Placement サービスの特性としての libvirt 仮想化ドライバー機能

libvirt 仮想化ドライバーの機能を Placement サービスの特性として使用することができます。指定することのできる特性は os-traits ライブラリーで定義されます。以下に例を示します。

-

COMPUTE_TRUSTED_CERTS -

COMPUTE_NET_ATTACH_INTERFACE_WITH_TAG -

COMPUTE_IMAGE_TYPE_RAW -

HW_CPU_X86_AVX -

HW_CPU_X86_AVX512VL -

HW_CPU_X86_AVX512CD

インスタンスが特定のハードウェア、仮想化、ストレージ、ネットワーク、またはデバイスの特性に要求することのできる標準化された定数のカタログについては、os-traits ライブラリー を参照してください。

以下の libvirt 仮想化ドライバーは、命令セットの種別 (SSE4、AVX、または AVX-512 等) など、ホスト CPU が提供する機能を自動的に Placement サービスに報告します。

- Libvirt QEMU (x86)

- Libvirt KVM (x86)

- Libvirt KVM (ppc64)

これらのドライバーのいずれかを使用している場合、インスタンス用にフレーバー追加スペックまたはイメージメタデータを設定して、リソースプロバイダーに特定の CPU 機能を要求することができます。

4.5.3.2. Placement サービス特性を使用したリソースプロバイダー要求の指定

以下の方法のいずれかを使用して、インスタンス用に要求するリソースプロバイダー特性を指定することができます。

以下の手順例では、インスタンスは特定の CPU 種別を要求します。

前提条件

-

Placement サービスのパッケージ

python3-osc-placementがアンダークラウドにインストールされている。 デプロイメントで、以下の

libvirt仮想化ドライバーのいずれかが使用されている。- Libvirt QEMU (x86)

- Libvirt KVM (x86)

- Libvirt KVM (ppc64)

手順: イメージメタデータを使用して特性を要求する

新規イメージを作成するか、既存のイメージを変更して、必要な特性を設定します。

openstack image create ... $IMAGE openstack image set --property trait:HW_CPU_X86_AVX512BW=required $IMAGE

$ openstack image create ... $IMAGE $ openstack image set --property trait:HW_CPU_X86_AVX512BW=required $IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow そのイメージを使用してインスタンスをブートします。

openstack server create --image=$IMAGE ... $SERVER_NAME

$ openstack server create --image=$IMAGE ... $SERVER_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 結果: AVX-512 をサポートするホストにインスタンスが作成されます。

手順: フレーバー追加スペックを使用して特性を要求する

新規フレーバーを作成するか、既存のフレーバーを変更して、必要な特性を設定します。

openstack flavor create ... $FLAVOR openstack flavor set --property trait:HW_CPU_X86_AVX512BW=required $FLAVOR

$ openstack flavor create ... $FLAVOR $ openstack flavor set --property trait:HW_CPU_X86_AVX512BW=required $FLAVORCopy to Clipboard Copied! Toggle word wrap Toggle overflow そのフレーバーを使用してインスタンスをブートします。

openstack server create --flavor=$FLAVOR ... $SERVER_NAME

$ openstack server create --flavor=$FLAVOR ... $SERVER_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 結果: AVX-512 をサポートするホストにインスタンスが作成されます。

4.5.4. 最小帯域幅を確保する QoS の設定

Quality of Service (QoS) ポリシーを使用して、最小帯域幅の確保を要求するインスタンスを作成することができます。

QoS ポリシーと最小帯域幅を確保するルールの組み合わせは、特定の物理ネットワーク上のポートに割り当てられます。設定したポートを使用するインスタンスを作成する場合、Compute のスケジューリングサービスは、この要求を満たすインスタンス用ホストを選択します。Compute のスケジューリングサービスは、インスタンスをデプロイするホストを選択する前に、他のインスタンスが各物理インターフェース上に確保する帯域幅を Placement サービスに問い合わせます。

制限/制約

- 新規インスタンスの作成時にのみ、最小帯域幅を確保する QoS ポリシーを割り当てることができます。Compute サービスがインスタンス用リソースの使用状況を更新するのは作成または移動操作時だけなので、すでに動作中のインスタンスに最小帯域幅を確保する QoS ポリシーを割り当てることはできません。つまり、インスタンスで利用可能な最小帯域幅を保証することはできません。

最小帯域幅を確保する QoS ポリシーなど、リソース要求が設定されたポートを使用するインスタンスのライブマイグレーションを行うことはできません。ポートにリソース要求が設定されているかどうかを確認するには、以下のコマンドを実行します。

openstack port show <port_name/port_id>

$ openstack port show <port_name/port_id>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

前提条件

- 最小帯域幅ルールの QoS ポリシーを利用することができる。詳しくは、「 Quality of Service(QoS)ポリシーの設定」を参照してください。

手順

利用可能な QoS ポリシーを一覧表示します。

(overcloud) $ openstack network qos policy list

(overcloud) $ openstack network qos policy listCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow 利用可能な各ポリシーのルールを確認して、必要な最小帯域幅に関するものを特定します。

(overcloud) $ openstack network qos policy show policy0

(overcloud) $ openstack network qos policy show policy0Copy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow 適切なポリシーからポートを作成します。

(overcloud) $ openstack port create port-normal-qos --network net0 --qos-policy policy0

(overcloud) $ openstack port create port-normal-qos --network net0 --qos-policy policy0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用する NIC ポートを指定して、インスタンスを作成します。

openstack server create --flavor cirros256 --image cirros-0.3.5-x86_64-disk --nic port-id=port-normal-qos --wait qos_instance

$ openstack server create --flavor cirros256 --image cirros-0.3.5-x86_64-disk --nic port-id=port-normal-qos --wait qos_instanceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力の「ACTIVE」ステータスは、要求された最小帯域幅を保証できるホストにインスタンスが正常に作成されていることを示しています。

4.5.4.1. インスタンスからの最小帯域幅を確保する QoS の削除

インスタンスから最小帯域幅を確保する QoS ポリシーの制約を外す場合、インターフェースの割り当てを解除することができます。

インターフェースの割り当てを解除するには、以下のコマンドを入力します。

openstack server remove port <vm_name|vm_id> <port_name|port_id>

$ openstack server remove port <vm_name|vm_id> <port_name|port_id>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5.5. PCI デバイスがアタッチされている NUMA ノードの確保

Compute はフィルタースケジューラーを使用して、PCI を要求するインスタンスに対して、PCI デバイスがアタッチされたホストの優先順位付けを行います。ホストの重み付けは、PCIWeigher オプションが使用して、ホスト上で利用可能な PCI デバイスの数と、インスタンスによって要求されている PCI デバイスの数に基づいて行われます。インスタンスが PCI デバイスを要求している場合は、より多くの PCI デバイスがアタッチされたホストに、他のホストよりも高い加重値が割り当てられます。インスタンスが PCI デバイスを要求していない場合には、優先順位付けは行われません。

この機能は、以下のような場合に特に役立ちます。

- オペレーターが、PCI デバイスを要求するゲストインスタンス向けに PCI デバイスがアタッチされたノード (通常は高コストでリソースが限定される) を確保する場合

- インスタンスを起動するユーザーが、必要時に PCI デバイスを利用できるようにする場合。

この値が考慮されるようにするには、Compute 環境ファイルの NovaSchedulerDefaultFilters パラメーターに、PciPassthroughFilter または NUMATopologyFilter どちらかの値を追加する必要があります。

pci_weight_multiplier 設定オプションは、正の値でなければなりません。

4.5.6. 専用の物理 CPU で実行されるエミュレータースレッドの設定

Compute のスケジューラーは、CPU リソースの使用状況を確認して、フレーバーの仮想 CPU (vCPU) 数に基づいてインスタンスを配置します。ゲストの代わりにホストで実行されるハイパーバイザー操作は数多くあります。たとえば、QEMU では、QEMU のメインイベントループや、非同期 I/O 操作などに使用されるスレッドがあるので、それらを考慮に入れて、別々にスケジュールする必要があります。

libvirt ドライバーは、KVM 向けの一般的な配置ポリシーを実装しています。このポリシーでは、仮想 CPU を実行しているのと同じ複数の物理 CPU (pCPU) 全体にわたって、QEMU エミュレータースレッドをフローティングさせることができます。これにより、エミュレータースレッドは、仮想 CPU 操作から借りた時間を使用することになります。ゲストに専用の仮想 CPU 割り当てが必要な場合には、エミュレータースレッドに 1 つまたは複数の物理 CPU を割り当てる必要があります。そのため、スケジューラーに対して、ゲストに関連する可能性のある他の CPU の用途を記述して、配置中にそれ計算に入れる必要があります。

NFV デプロイメントでは、パケットロスを回避するために、仮想 CPU が割り込まれないようにする必要があります。

フレーバー上でエミュレータースレッドの配置ポリシーを有効にする前に、以下に示すように heat パラメーターが定義されていることを確認する必要があります。

-

NovaComputeCpuSharedSet: このパラメーターには、エミュレータースレッドを実行するように定義された CPU の一覧を設定します。 -

NovaSchedulerDefaultFilters: 定義するフィルターの一覧にNUMATopologyFilterを含めます。

これらの変更を適用するには、アクティブなクラスターで heat パラメーターの値を定義または変更してから再デプロイします。

エミュレータースレッドを分離するには、以下のように設定したフレーバーを使用する必要があります。

openstack flavor set FLAVOR-NAME \ --property hw:cpu_policy=dedicated \ --property hw:emulator_threads_policy=share

# openstack flavor set FLAVOR-NAME \

--property hw:cpu_policy=dedicated \

--property hw:emulator_threads_policy=share4.6. インスタンスのスナップショットの管理

インスタンスのスナップショットを使用すると、インスタンスから新規イメージを作成することができます。これは、ベースイメージのアップロードや、公開イメージを取得してローカルで使用するためにカスタマイズする際に非常に便利です。

Image サービスに直接アップロードしたイメージと、スナップショットで作成したイメージの相違点は、スナップショットで作成したイメージには Image サービスデータベースのプロパティーが追加されている点です。これらのプロパティーは image_properties テーブルにあり、以下のパラメーターが含まれます。

| 名前 | 値 |

|---|---|

| image_type | snapshot |

| instance_uuid | <スナップショットを作成したインスタンスの uuid> |

| base_image_ref | <スナップショットを作成したインスタンスのオリジナルイメージの uuid> |

| image_location | snapshot |

スナップショットでは、指定のスナップショットをベースにして新規インスタンスを作成して、その状態にインスタンスを復元することができます。さらに、インスタンスの実行中にスナップショットを作成や復元が可能です。

デフォルトでは、スナップショットをベースとするインスタンスが起動している間は、選択したユーザーとプロジェクトがそのスナップショットにアクセスできます。

4.6.1. インスタンスのスナップショットの作成

インスタンスのスナップショットをテンプレートとして使用して新規インスタンスを作成する場合には、ディスクの状態が一貫していることを確認してください。スナップショットを作成する前に、スナップショットのイメージメタデータのプロパティーを os_require_quiesce=yes に設定します。以下に例を示します。

glance image-update IMAGE_ID --property os_require_quiesce=yes

$ glance image-update IMAGE_ID --property os_require_quiesce=yes

このコマンドが機能するには、ゲストに qemu-guest-agent パッケージがインストール済みで、メタデータプロパティーのパラメーターを hw_qemu_guest_agent=yes に指定してイメージを作成する必要があります。以下に例を示します。

hw_qemu_guest_agent=yes パラメーターを無条件で有効化した場合には、別のデバイスをゲストに追加してください。この設定により、PCI スロットが使用され、ゲストに割り当てることのできる他のデバイスの数が制限されます。また、これにより、Windows ゲストでは、未知のハードウェアデバイスについての警告のメッセージが表示されます。

このような理由により、hw_qemu_guest_agent=yes パラメーターの設定はオプションとなっており、QEMU ゲストエージェントを必要とするそれらのイメージにのみ使用すべきです。

- Dashboard で プロジェクト > コンピュート > インスタンス を選択します。

- スナップショットを作成するインスタンスを選択します。

- アクション コラムで、スナップショットの作成 をクリックします。

スナップショットの作成 ダイアログでは、スナップショットの名前を入力して スナップショットの作成 をクリックします。

イメージ カテゴリーには、インスタンスのスナップショットが表示されます。

スナップショットからインスタンスを起動するには、スナップショットを選択して 起動 をクリックします。

4.6.2. スナップショットの管理

- Dashboard で プロジェクト > イメージ を選択します。

- 作成したスナップショットはすべて プロジェクト オプションの下に表示されます。

作成するスナップショットごとに、ドロップダウンリストを使用して以下の機能を実行できます。

- ボリュームの作成 オプションを使用して、ボリュームを作成してボリューム名の値、説明、イメージソース、ボリューム種別、サイズ、アベイラビリティーゾーンを入力します。詳細は、『 ストレージガイド』 の「 ボリュームの作成」を 参照してください。

- イメージの編集 オプションを使用して、名前、説明、カーネル ID、Ramdisk ID、アーキテクチャー、形式、最小ディスク (GB)、最小メモリー (MB)、パブリックまたはプライベートを更新して、スナップショットのイメージを更新します。詳細は、「イメージの更新」を参照してください。

- イメージの削除 オプションを使用してスナップショットを削除します。

4.6.3. スナップショットの状態へのインスタンスの再ビルド

スナップショットがベースとなっているインスタンスを削除する場合には、スナップショットにはインスタンス ID が保存されます。nova image-list コマンドを使用してこの情報を確認して、スナップショットでインスタンスを復元します。

- Dashboard で プロジェクト > コンピュート > イメージ を選択します。

- インスタンスを復元するスナップショットを選択します。

- アクション コラムで、インスタンスの起動 をクリックします。

- インスタンスの起動 ダイアログで、インスタンスの名前とその他の詳細を入力して 起動 をクリックします。

インスタンスの起動に関する詳細は、「インスタンスの起動」を参照してください。

4.6.4. 一貫性のあるスナップショット

以前のリリースでは、バックアップの一貫性を確保するには、アクティブなインスタンスのスナップショットを作成する前にファイルシステムを手動で停止 (fsfreeze) する必要がありました。

Compute の libvirt ドライバーは、QEMU ゲストーエージェント に、イメージのスナップショット作成中ファイルシステムを (fsfreeze-hook がインストールされている場合には、アプリケーションも対象) フリーズするように自動的に要求するようになりました。ファイルシステムの停止に対するサポートにより、スケジュールされた自動スナップショット作成をブロックデバイスレベルで実行できるようになりました。

この機能は、QEMU ゲストエージェント (qemu-ga) がインストール済みで、かつイメージのメタデータで有効化されている (hw_qemu_guest_agent=yes) 場合にのみ有効です。

スナップショットは、実際のシステムバックアップの代わりとみなすべきではありません。

4.7. インスタンスのレスキューモードの使用

Compute では、仮想マシンをレスキューモードで再起動する方法があります。レスキューモードは、仮想マシンイメージが原因で、インスタンスがアクセス不可能な状態となっている場合に、そのインスタンスにアクセスするためのメカニズムを提供します。レスキューモードの仮想マシンは、ユーザーが仮想マシンに新規 root パスワードを使用してアクセスし、そのマシンを修復することができます。この機能は、インスタンスのファイルシステムが破損した場合に役立ちます。デフォルトでは、レスキューモードのインスタンスは初期イメージから起動して、第 2 のイメージとして現在のブートディスクをアタッチします。

4.7.1. レスキューモードのインスタンス用イメージの準備

ブートディスクとレスキューモード用のディスクには同じ UUID が使用されているため、仮想マシンがレスキューモード用のディスクの代わりにブートディスクから起動されてしまう可能性があります。

この問題を回避するには、「イメージの作成」の手順に従い、レスキューイメージとして新しいイメージを作成してください。

rescue イメージは、デフォルトでは glance に保管され、nova.conf で設定されていますが、レスキューを実行する際に選択することもできます。

4.7.1.1. ext4 ファイルシステムを使用している場合のレスキューイメージ

ベースイメージが ext4 ファイルシステムを使用する場合には、以下の手順を使用してそれをベースにレスキューイメージを作成できます。

tune2fsコマンドを使用して、UUID を無作為な値に変更します。tune2fs -U random /dev/DEVICE_NODE

# tune2fs -U random /dev/DEVICE_NODECopy to Clipboard Copied! Toggle word wrap Toggle overflow DEVICE_NODE はルートデバイスノードに置き換えます (例:

sda、vdaなど)。新しい UUID を含む、ファイルシステムの詳細を確認します。

tune2fs -l

# tune2fs -lCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

/etc/fstabファイルで UUID を新しい値に置き換えます。fstabにマウントされている追加のパーティションがある場合には、UUID を新しい値に置き換える必要がある場合があります。 -

/boot/grub2/grub.confファイルを更新し、ルートディスクの UUID パラメーターを新しい UUID に置き換えます。 - シャットダウンして、このイメージをレスキューイメージに使用します。これにより、レスキューイメージには新たに無作為な UUID が割り当てられ、レスキューするインスタンスとの競合が発生しなくなります。

XFS ファイルシステムでは、実行中の仮想マシン上のルートデバイスの UUID は変更できません。仮想マシンがレスキューモード用のディスクから起動するまで再起動を続けます。

4.7.2. OpenStack Image サービスへのレスキューイメージの追加

対象のイメージの UUID を変更したら、以下のコマンドを実行して、生成されたレスキューイメージを OpenStack Image サービスに追加します。

Image サービスにレスキューイメージを追加します。

glance image-create --name IMAGE_NAME --disk-format qcow2 \ --container-format bare --is-public True --file IMAGE_PATH

# glance image-create --name IMAGE_NAME --disk-format qcow2 \ --container-format bare --is-public True --file IMAGE_PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow IMAGE_NAME は、イメージの名前に、IMAGE_PATH はイメージの場所に置き換えます。

image-listコマンドを使用して、インスタンスをレスキューモードで起動するのに必要な IMAGE_ID を取得します。glance image-list

# glance image-listCopy to Clipboard Copied! Toggle word wrap Toggle overflow

OpenStack Dashboard を使用してイメージをアップロードすることも可能です。「イメージのアップロード」を参照してください。

4.7.3. レスキューモードでのインスタンスの起動

デフォルトのイメージではなく、特定のイメージを使用してインスタンスをレスキューする必要があるため、

--imageパラメーターを使用します。nova rescue --image IMAGE_ID VIRTUAL_MACHINE_ID

# nova rescue --image IMAGE_ID VIRTUAL_MACHINE_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow IMAGE_ID は使用するイメージ ID に、VIRTUAL_MACHINE_ID はレスキューする仮想マシンの ID に置き換えます。

注記nova rescueコマンドを使用すると、インスタンスでソフトシャットダウンを実行することができます。これにより、ゲストオペレーティングシステムは、インスタンスの電源をオフにする前に、制御されたシャットダウンを実行することができます。シャットダウンの動作は、Compute 設定ファイルのshutdown_timeoutを使用して設定されます。この値は、ゲストオペレーティングシステムが完全にシャットダウンするまでの合計時間 (秒単位) を指定します。デフォルトのタイムアウトは 60 秒です。このタイムアウト値は、

os_shutdown_timeoutでイメージ毎に上書きすることが可能です。これは、異なるタイプのオペレーティングシステムでクリーンにシャットダウンするために必要な時間を指定するイメージのメタデータ設定です。- 仮想マシンを再起動します。

-

nova listコマンドまたは Dashboard を使用して、コントローラーノード上で仮想マシンのステータスが RESCUE であることを確認します。 - レスキューモード用のパスワードを使用して、新しい仮想マシンのダッシュボードにログインします。

これで、インスタンスに必要な変更を加えて、問題を修正できる状態となりました。

4.7.4. インスタンスのアンレスキュー

修正したインスタンスは unrescue して、ブートディスクから再起動することができます。

コントローラーノードで以下のコマンドを実行します。

nova unrescue VIRTUAL_MACHINE_ID

# nova unrescue VIRTUAL_MACHINE_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow VIRTUAL_MACHINE_ID はアンレスキューする仮想マシンの ID に置き換えます。

アンレスキューの操作が正常に完了すると、インスタンスのステータスは ACTIVE に戻ります。

4.8. インスタンス用のコンフィグドライブの設定

config-drive パラメーターを使用して、読み取り専用のドライブをインスタンスに公開することができます。ファイルを選択してこのドライブに追加すると、インスタンスにアクセスできるようになります。コンフィグドライブは、起動時にインスタンスにアタッチされて、パーティションとしてインスタンスに公開されます。コンフィグドライブは、cloud-init (サーバーのブートストラップ用) と組み合わせる場合や、インスタンスに大容量のファイルを渡す場合に有用です。

4.8.1. コンフィグドライブのオプション

Compute 環境ファイルを使用して、以下のコンフィグドライブパラメーターを設定します。

-

config_drive_format: ドライブの形式を設定して、iso9660とvfatのオプションを確定します。デフォルトではiso9660を使用します。 -

force_config_drive: このオプションでは、全インスタンスにコンフィグドライブを強制的に公開します。「true」に設定します。 -

mkisofs_cmd: ISO ファイルの作成に使用するコマンドを指定します。genisoimage しかサポートされないので、この値は変更しないでください。

4.8.2. コンフィグドライブの使用

インスタンスは、ブート時にコンフィグドライブをアタッチします。これは、--config-drive オプションで有効になります。たとえば、このコマンドは test-instance01 という名前の新しいインスタンスを作成して、/root/user-data.txt という名前のファイルが含まれるドライブをアタッチします。

nova boot --flavor m1.tiny --config-drive true --file /root/user-data.txt=/root/user-data.txt --image cirros test-instance01

# nova boot --flavor m1.tiny --config-drive true --file /root/user-data.txt=/root/user-data.txt --image cirros test-instance01インスタンスが起動すると、そのインスタンスにログインして、/root/user-data.txt という名前のファイルを確認できます。

このコンフィグドライブを cloud-init の情報源として使用できます。インスタンスの初回起動中には、cloud-init は自動的にコンフィグドライブをマウントして、設定スクリプトを実行することができます。

第5章 コンピュートノード間の仮想マシンインスタンスの移行

メンテナンスを実行する場合やワークロードのリバランスを行う場合、あるいは障害が発生した/障害が発生しつつあるノードを置き換える場合に、あるコンピュートノードからオーバークラウド内の別のコンピュートノードにインスタンスを移行しなければならない場合があります。

- コンピュートノードのメンテナンス

- ハードウェアのメンテナンスや修理、カーネルのアップグレードおよびソフトウェアの更新を行うなどの理由により、コンピュートノードを一時的に停止する必要がある場合、コンピュートノード上で実行中のインスタンスを別のコンピュートノードに移行することができます。

- 障害が発生しつつあるコンピュートノード

- コンピュートノードで障害が発生する可能性があり、ノードのサービスまたは置き換えが必要な場合、障害が発生しつつあるコンピュートノードから正常なコンピュートノードにインスタンスを移行することができます。

- 障害が発生したコンピュートノード

- コンピュートノードですでに障害が発生している場合には、インスタンスを退避させることができます。同じ名前、UUID、ネットワークアドレス、およびコンピュートノードに障害が発生する前にインスタンスに割り当てられていたその他すべてのリソースを使用して、元のイメージから別のコンピュートノードにインスタンスを再ビルドすることができます。

- ワークロードのリバランス

- ワークロードをリバランスするために、1 つまたは複数のインスタンスを別のコンピュートノードに移行することができます。たとえば、コンピュートノード上のインスタンスを 1 つにまとめて電力を節約する、他のネットワークリソースに物理的に近いコンピュートノードにインスタンスを移行してレイテンシーを低減する、インスタンスを全コンピュートノードに分散してホットスポットをなくし復元力を向上させる、等が可能です。