Red Hat Quay の管理

はじめに

Red Hat Quay レジストリーを展開した後、その展開をさらに設定、管理する方法は数多くあります。ここでは、以下のようなトピックを取り上げています。

- Red Hat Quay の高度な設定

- Red Hat Quay の新リリースを知らせる通知の設定

- SSL および TLS 証明書による接続の保護

- アクションログのストレージの Elasticsearch へのダイレクト

- Clair によるイメージセキュリティースキャンの設定

- コンテナーセキュリティー Operator での Pod イメージのスキャン

- Quay Bridge Operator を使用した Red Hat Quay の OpenShift への統合

- リポジトリーミラーリングによるイメージの反映

- BitTorrent サービスによる Quay イメージの共有

- LDAP によるユーザーの認証

- Prometheus および Grafana メトリクスの Quay の有効化

- Geo レプリケーションの設定

- Quay のトラブルシューティング

第1章 Red Hat Quay の高度な設定

以下のインターフェイスのいずれかを使用して、初期デプロイメント後に Red Hat Quay を設定できます。

-

Red Hat Quay 設定ツール。このツールにより、

Quayコンテナーをconfigモードで実行する際に、Red Hat Quay クラスターを設定するための Web ベースのインターフェイスが提供されます。この方法は、Red Hat Quay サービスを設定する場合に推奨されます。 -

config.yamlの編集。config.yamlファイルには、Red Hat Quay クラスターのほとんどの設定情報が含まれています。config.yamlファイルを直接編集することは可能ですが、Config Tool では利用できない高度なチューニングやパフォーマンス機能を利用する場合にのみお勧めします。 - Red Hat Quay API。一部の Red Hat Quay 機能は、API を介して設定できます。

このセクションのこのコンテンツでは、前述の各インターフェイスの使用方法と、高度な機能を使用してデプロイメントを設定する方法について説明します。

1.1. Red Hat Quay Config Tool を使用した Red Hat Quay の変更

Red Hat Quay Config Tool は、通常の Red Hat Quay サービスと共に config モードで Quay コンテナーを実行して利用できます。

以下のセクションを使用して、Red Hat Quay Operator から Config Tool を実行するか、コマンドラインインターフェイス (CLI) からホストシステムで Config Tool を実行します。

1.1.1. Red Hat Quay Operator からの Config Tool の実行

OpenShift Container Platform で Red Hat Quay Operator を実行すると、Config Tool をすぐに使用できます。以下の手順を使用して、Red Hat Quay Config Tool にアクセスします。

前提条件

- Red Hat Quay Operator を OpenShift Container Platform にデプロイしている。

手順

-

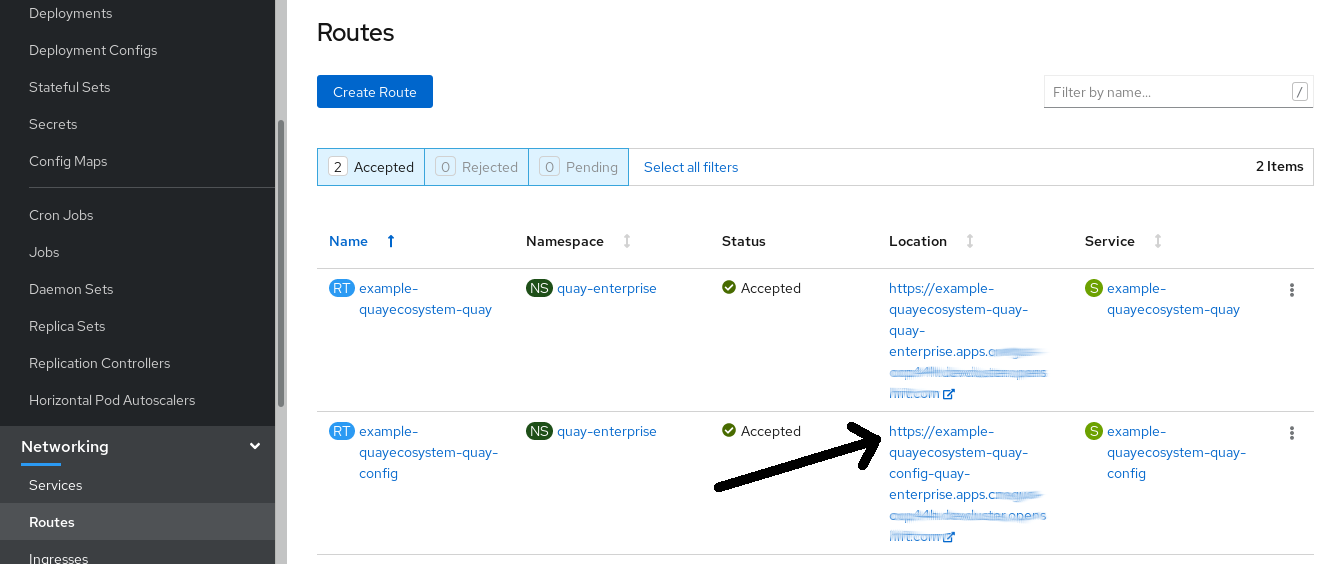

OpenShift コンソールで、

quay-enterpriseなどの Red Hat Quay プロジェクトを選択します。 ナビゲーションペインで Networking → Routes を選択します。次のイメージに示すように、Red Hat Quay アプリケーションと Config Tool の両方へのルートが表示されます。

-

Config Tool へのルート (例:

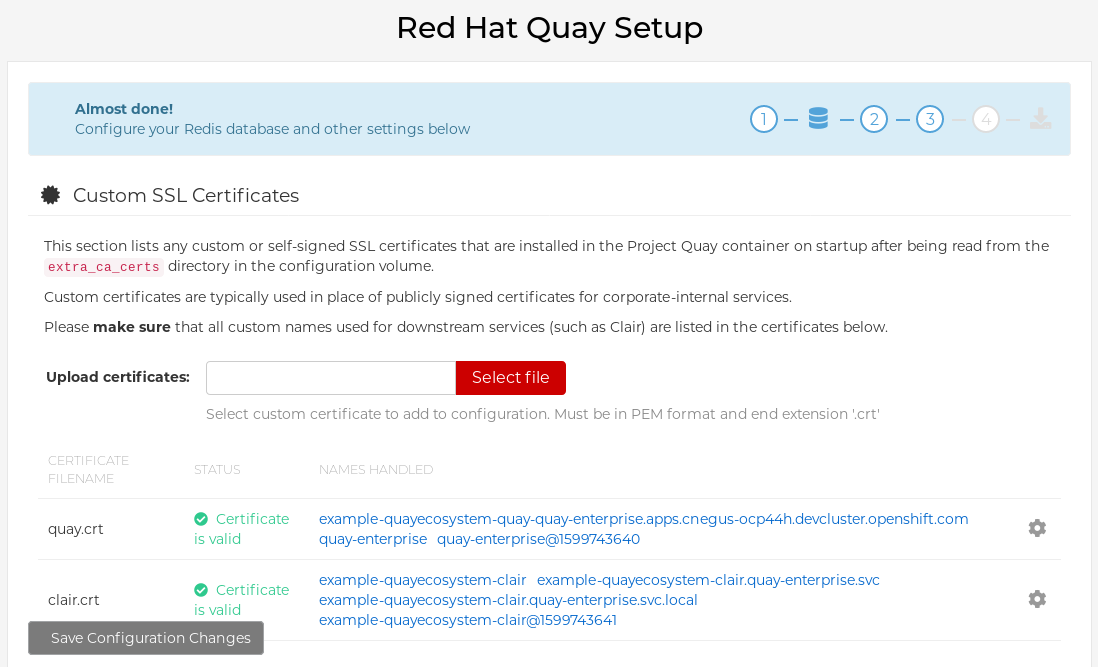

example-quayecosystem-quay-config) を選択します。ブラウザーに Config Tool UI が表示されます。 Modify configuration for this cluster を選択して、Config Tool のセットアップを表示します。次に例を示します。

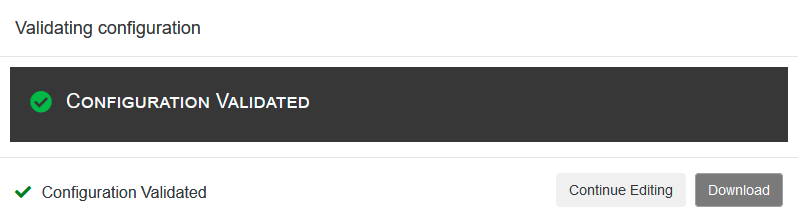

- 必要な変更を行い、Save Configuration Changes を選択します。

- Continue Editing をクリックして必要な修正を行うか、Next を選択して続行します。

-

プロンプトが表示されたら、Download Configuration を選択します。これにより、新しい

config.yamlの tarball と、Red Hat Quay のセットアップで使用された証明書や鍵がダウンロードされます。config.yamlを使用して、設定に高度な変更を加えたり、将来の参照として使用したりできます。 - Go to deployment rollout → Populate the configuration to deployments を選択します。Red Hat Quay Pod が再起動し、変更が有効になるのを待ちます。

1.1.2. コマンドラインからの Config Tool の実行

ホストシステムから Red Hat Quay を実行している場合は、以下の手順を使用して、初期デプロイメント後に設定を変更できます。

前提条件

-

podmanまたはdockerがインストールされていること。

-

- 設定モードで Red Hat Quay を起動します。

最初の

Quayノードで、次のコマンドを入力します。podman run --rm -it --name quay_config -p 8080:8080 \ -v path/to/config-bundle:/conf/stack \ {productrepo}/{quayimage}:{productminv} config <my_secret_password>$ podman run --rm -it --name quay_config -p 8080:8080 \ -v path/to/config-bundle:/conf/stack \ {productrepo}/{quayimage}:{productminv} config <my_secret_password>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記既存の設定バンドルを変更するには、設定ディレクトリーを

Quayコンテナーにマウントできます。-

Red Hat Quay 設定ツールが起動したら、ブラウザーを開き、設定ファイルで使用されている URL とポート (例:

quay-server.example.com:8080) に移動します。 - ユーザー名およびパスワードを入力します。

- 必要に応じて Red Hat Quay クラスターを変更します。

1.1.3. TLS 証明書を使用した設定ツールのデプロイ

環境変数をランタイム変数に渡すことで、セキュアな TLS 証明書を使用して設定ツールをデプロイできます。これにより、データベースやストレージバックエンドの認証情報などの機密データが確実に保護されます。

公開鍵と秘密鍵には、設定ツールをデプロイするルートの有効なサブジェクト代替名 (SAN) が含まれている必要があります。

パスは CONFIG_TOOL_PRIVATE_KEY および CONFIG_TOOL_PUBLIC_KEY を使用して指定できます。

コンテナーからデプロイを実行している場合、CONFIG_TOOL_PRIVATE_KEY 値と CONFIG_TOOL_PUBLIC_KEY 値は、コンテナー内の証明書の場所になります。以下はその例です。

1.2. API を使用した Red Hat Quay の変更

Red Hat Quay API へのアクセス方法については、Red Hat Quay API ガイド を参照してください。

1.3. config.yaml ファイルを編集して Red Hat Quay の変更

Config Tool では使用できない一部の高度な設定機能は、config.yaml ファイルを直接編集することで実装できます。利用可能な設定は Schema for Red Hat Quay configuration 説明されています。

次の例は、config.yaml ファイルで直接変更できる設定です。

1.3.1. Red Hat Quay のサインインに名前と会社を追加

次のフィールドを設定すると、ユーザーは最初のサインイン時に名前と会社の入力を求められます。これはオプションのフィールドですが、Red Hat Quay ユーザーに関する追加データを提供できます。

--- FEATURE_USER_METADATA: true ---

---

FEATURE_USER_METADATA: true

---1.3.2. TLS プロトコルの無効化

SSL_PROTOCOLS 設定を変更して、Red Hat Quay インスタンスでサポートしたくない SSL プロトコルを削除することができます。たとえば、デフォルトの SSL_PROTOCOLS:['TLSv1','TLSv1.1','TLSv1.2'] から TLS v1 のサポートを削除するには、以下のように変更します。

--- SSL_PROTOCOLS : ['TLSv1.1','TLSv1.2'] ---

---

SSL_PROTOCOLS : ['TLSv1.1','TLSv1.2']

---1.3.3. API コールのレート制限

config.yaml ファイルに FEATURE_RATE_LIMITS パラメーターを追加すると、nginx は特定の API 呼び出しを 1 秒あたり 30 回に制限します。FEATURE_RATE_LIMITS が設定されていない場合、API 呼び出しは 1 秒あたり 300 回に制限され、実質的に無制限になります。

レート制限は、使用可能なリソースがトラフィックで圧倒されないようにする必要がある場合に重要です。

一部の名前空間は、CI/CD にとって重要であり、優先される場合など、無制限のアクセスが必要になる場合があります。このシナリオでは、これらの名前空間は、NON_RATE_LIMITED_NAMESPACES を使用して config.yaml ファイルのリストに配置される場合があります。

1.3.4. データベースのコネクションプールの調整

Red Hat Quay は、すべてが同じコンテナー内で実行する多くの異なるプロセスで設定されています。これらのプロセスの多くは、データベースと連動しています。

DB_CONNECTION_POOLING パラメーターを使用すると、データベースと対話する各プロセスに接続プールが含まれます。これらのプロセスごとの接続プールは、最大 20 の接続を維持するように設定されます。高負荷時には、Red Hat Quay コンテナー内のすべてのプロセスの接続プールを満たすことが可能です。特定のデプロイメントや負荷の下では、Red Hat Quay がデータベースの設定された最大接続数を超えないようにするために分析が必要になる場合があります。

時間が経つと、接続プールはアイドル接続を解放します。すべての接続をすぐに解除するには、Red Hat Quay の再起動が必要です。

DB_CONNECTION_POOLING を true または false に設定することで、データベース接続プールを切り替えることができます。以下はその例です。

--- DB_CONNECTION_POOLING: true ---

---

DB_CONNECTION_POOLING: true

---

DB_CONNECTION_POOLING が有効になっている場合、config.yaml の DB_CONNECTION_ARGS で接続プールの最大サイズを変更できます。以下はその例です。

--- DB_CONNECTION_ARGS: max_connections: 10 ---

---

DB_CONNECTION_ARGS:

max_connections: 10

---1.3.4.1. データベース接続引数

Red Hat Quay のデータベース接続設定は、config.yaml ファイル内でカスタマイズすることができます。これらは、デプロイメントのデータベースドライバー (Postgres の場合は psycopg2、MySQL の場合は pymysql など) に依存します。Peewee の接続プールメカニズムで使用される引数を渡すこともできます。以下はその例です。

1.3.4.2. データベース SSL 設定

DB_CONNECTION_ARGS フィールドで定義されているキーと値のペアには、一般的なものもあれば、データベース固有のものもあります。特に、SSL 設定は、デプロイするデータベースによって異なります。

1.3.4.2.1. PostgreSQL SSL 接続引数

次の YAML は、サンプルの PostgreSQL SSL 設定を示しています。

--- DB_CONNECTION_ARGS: sslmode: verify-ca sslrootcert: /path/to/cacert ---

---

DB_CONNECTION_ARGS:

sslmode: verify-ca

sslrootcert: /path/to/cacert

---

sslmode パラメーターは、安全な SSL TCP/IP 接続がサーバーにネゴシエートされるかどうか、その優先度を決定します。sslmode パラメーターには 6 つのモードがあります。

- disabl: SSL 以外の接続のみを試行します。

- allow: 最初に SSL 以外の接続を試行します。失敗した場合は、SSL 接続を試みます。

- prefer: デフォルト。最初に SSL 接続を試してください。失敗した場合は、SSL 以外の接続を試してください。

-

require: SSL 接続のみを試行します。ルート CA ファイルが存在する場合は、

verify-caが指定された場合と同じ方法で接続を検証します。 - verify-ca: SSL 接続のみを試行し、信頼された認証局 (CA) によりサーバー証明書が発行されていることを確認します。

- verify-full: SSL 接続のみを試行します。信頼された CA によりサーバー証明書が発行され、要求されたサーバーのホスト名が証明書のホスト名と一致することを確認します。

PostgreSQL の有効な引数の詳細は、Database Connection Control Functions を参照してください。

1.3.4.2.2. MySQL SSL 接続引数

次の YAML は、サンプルの MySQL SSL 設定を示しています。

---

DB_CONNECTION_ARGS:

ssl:

ca: /path/to/cacert

---

---

DB_CONNECTION_ARGS:

ssl:

ca: /path/to/cacert

---MySQL の有効な接続引数の詳細については、Connecting to the Server Using URI-Like Strings or Key-Value Pairs を参照してください。

1.3.4.3. HTTP 接続回数

環境変数を使用して、HTTP の同時接続数を指定することができます。環境変数は、全体として、または特定のコンポーネントに対して指定できます。それぞれのデフォルトは、1 プロセスあたり 50 並列接続です。環境変数の例については、次の YAML を参照してください。

特定のコンポーネントの数を指定すると、WORKER_CONNECTION_COUNT 設定フィールドに設定されたすべての値が上書きされます。

1.3.4.4. ダイナミックなプロセスカウント

ダイナミックサイズのプロセスの量を推定するために、デフォルトでは以下の計算が行われます。

Red Hat Quay は、マシン全体から利用可能な CPU 数を照会します。kubernetes またはその他の仮想化されていないメカニズムを使用して適用される制限は、この動作には影響しません。Red Hat Quay は、ノード上のプロセッサーの総数に基づいて計算を行います。記載されているデフォルト値は単なる目標値であり、最大値を超えてはならず、最小値を下回ってはならない。

以下の各プロセス量は、以下に指定する環境変数でオーバーライドすることができます。

registry - レジストリーアクションを処理するための HTTP エンドポイントを提供します。

- 最小値: 8

- 最大値: 64

- デフォルト: $CPU_COUNT x 4

- 環境変数: WORKER_COUNT_REGISTRY

web - ウェブベースのインターフェイス用の HTTP エンドポイントを提供します

- 最小値: 2

- 最大値: 32

- デフォルト: $CPU_COUNT x 2

- 環境変数: WORKER_COUNT_WEB

secscan - Clair と相互作用します。

- 最小値: 2

- 最大値: 4

- デフォルト: $CPU_COUNT x 2

- 環境変数: WORKER_COUNT_SECSCAN

1.3.4.5. 環境変数

Red Hat Quay では、環境変数を使用してデフォルトの動作をオーバーライドすることができます。以下の表では、各変数と、使用できる値を一覧にして説明しています。

| 変数 | 説明 | 値 |

|---|---|---|

| WORKER_COUNT_REGISTRY |

| 8 ~ 64 の整数 |

| WORKER_COUNT_WEB | コンテナー内で UI/Web リクエストを処理するプロセスの数を指定します。 | 2 ~ 32 の整数 |

| WORKER_COUNT_SECSCAN | コンテナー内でセキュリティースキャン (Clair など) の統合を処理するプロセス数を指定します。 | 2 ~ 4 の整数 |

| DB_CONNECTION_POOLING | データベースのコネクションプーリングを切り替えます。 | true または false |

1.3.4.6. コネクションプーリングの停止

大量のユーザーアクティビティーを伴う Red Hat Quay の展開では、定期的に最大 2k のデータベース接続制限に達することがあります。このような場合、Red Hat Quay でデフォルトで有効になっているコネクションプーリングは、データベース接続数が指数関数的に増加する原因となるため、コネクションプーリングをオフにする必要があります。

接続プールをオフにするだけでは、データベース接続制限値の 2k に達することを阻止できない場合は、問題に対処するための追加の手順を踏む必要があります。この場合、ワークロードに合わせてデータベースの最大接続数を増やす必要があるかもしれません。

第2章 コンフィグレーション API の利用

コンフィグレーションツールは、設定の構築、検証、バンドル、およびデプロイに使用できる 4 つのエンドポイントを示します。config-tool の API は、https://github.com/quay/config-tool/blob/master/pkg/lib/editor/API.md に記載されています。ここでは、API を使用して現在の設定を取得する方法と、変更した内容を検証する方法について説明します。

2.1. 初期設定値の取得

初めてコンフィグレーションツールを実行するときに、既存のコンフィグレーションがない場合は、デフォルトのコンフィグレーションを取得することができます。コンテナーをコンフィグモードで起動します。

sudo podman run --rm -it --name quay_config \ -p 8080:8080 \ registry.redhat.io/quay/quay-rhel8:v3.7.13 config secret

$ sudo podman run --rm -it --name quay_config \

-p 8080:8080 \

registry.redhat.io/quay/quay-rhel8:v3.7.13 config secret

デフォルトを取得するには、コンフィグレーション API の config エンドポイントを使用します。

curl -X GET -u quayconfig:secret http://quay-server:8080/api/v1/config | jq

$ curl -X GET -u quayconfig:secret http://quay-server:8080/api/v1/config | jq返される値は、JSON 形式によるデフォルト設定です。

2.2. 現在の設定の取得

すでに Quay レジストリーを設定してデプロイしている場合は、コンテナーを停止してコンフィグレーションモードで再起動し、既存のコンフィグレーションをボリュームとして読み込みます。

sudo podman run --rm -it --name quay_config \ -p 8080:8080 \ -v $QUAY/config:/conf/stack:Z \ registry.redhat.io/quay/quay-rhel8:v3.7.13 config secret

$ sudo podman run --rm -it --name quay_config \

-p 8080:8080 \

-v $QUAY/config:/conf/stack:Z \

registry.redhat.io/quay/quay-rhel8:v3.7.13 config secret

現在の設定を取得するには、API の config エンドポイントを使用します。

curl -X GET -u quayconfig:secret http://quay-server:8080/api/v1/config | jq

$ curl -X GET -u quayconfig:secret http://quay-server:8080/api/v1/config | jq返される値は、データベースと Redis の設定データを含む、JSON 形式の現在の設定です。

2.3. API による設定の検証

設定を検証するには、config/validate エンドポイントに設定を投稿します。

返される値は、設定で見つかったエラーを含む配列です。設定が有効であれば、空の配列 [] が返されます。

2.4. 必須項目の決定

空の設定構造を config/validate エンドポイントに投稿することで、必須フィールドを決定することができます。

返される値は、どのフィールドが必須であるかを示す配列です。

第3章 Red Hat Quay のリリース通知の取得

Red Hat Quay の最新リリースや Red Hat Quay に関連するその他の変更を確認するには、Red Hat Customer Portal で更新通知に登録してください。通知に登録すると、Red Hat Quay の新しいバージョン、ドキュメントの更新、その他の Red Hat Quay のニュースをお知らせする通知を受け取ることができます。

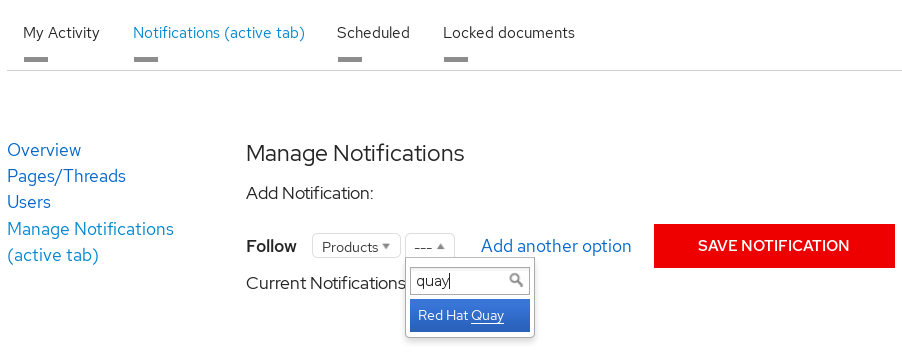

- Red Hat カスタマーアカウントの認証情報を使用して Red Hat カスタマーポータル にログインします。

-

ユーザー名 (右上隅) を選択して、Red Hat アカウントとカスタマーポータルの選択を表示します。

- Notifications を選択します。あなたのプロフィール活動ページが表示されます。

- Notifications タブを選択します。

- Manage Notifications を選択します。

- Follow を選択し、ドロップダウンボックスから Product を選択します。

-

製品の横にあるドロップダウンボックスで、Red Hat Quay を検索して選択します。

- SAVE NOTIFICATION ボタンを選択します。今後、Red Hat Quay 製品に新しいリリースなどの変更があった場合には、通知が届きます。

第4章 SSL を使用した Red Hat Quay への接続の保護

4.1. SSL の使用について

自己署名証明書 で Red Hat Quay を設定するには、認証局 (CA) を作成し、必要なキーおよび証明書ファイルを生成する必要があります。

以下の例では、/etc/hosts ファイルにエントリーを追加するなど、DNS または別の命名メカニズムを使用してサーバーホスト名 quay-server.example.com を設定していることを前提としています。

cat /etc/hosts ... 192.168.1.112 quay-server.example.com

$ cat /etc/hosts

...

192.168.1.112 quay-server.example.com4.2. 認証局を作成して証明書に署名

この手順の最後に、証明書ファイルと、ssl.cert および ssl.key という名前のプライマリーキーファイルがあります。

4.2.1. 認証局の作成

ルート CA キーを生成します。

openssl genrsa -out rootCA.key 2048

$ openssl genrsa -out rootCA.key 2048Copy to Clipboard Copied! Toggle word wrap Toggle overflow ルート CA 証明書を生成します。

openssl req -x509 -new -nodes -key rootCA.key -sha256 -days 1024 -out rootCA.pem

$ openssl req -x509 -new -nodes -key rootCA.key -sha256 -days 1024 -out rootCA.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow サーバーのホスト名など、証明書の要求に組み込まれる情報を入力します。以下に例を示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.2. 証明書に署名

サーバーキーを生成します。

openssl genrsa -out ssl.key 2048

$ openssl genrsa -out ssl.key 2048Copy to Clipboard Copied! Toggle word wrap Toggle overflow 署名要求を生成します。

openssl req -new -key ssl.key -out ssl.csr

$ openssl req -new -key ssl.key -out ssl.csrCopy to Clipboard Copied! Toggle word wrap Toggle overflow サーバーのホスト名など、証明書の要求に組み込まれる情報を入力します。以下に例を示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のようにサーバーのホスト名を指定して、設定ファイルの

openssl.cnfを作成します。openssl.cnf

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 設定ファイルを使用して、証明書

ssl.certを生成します。openssl x509 -req -in ssl.csr -CA rootCA.pem -CAkey rootCA.key -CAcreateserial -out ssl.cert -days 356 -extensions v3_req -extfile openssl.cnf

$ openssl x509 -req -in ssl.csr -CA rootCA.pem -CAkey rootCA.key -CAcreateserial -out ssl.cert -days 356 -extensions v3_req -extfile openssl.cnfCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3. コマンドラインを使用した SSL の設定

別の方法として、コマンドラインインターフェイスを使用できます。

証明書ファイルとプライマリーキーファイルを設定ディレクトリーにコピーして、それぞれ

ssl.certとssl.keyという名前が付けられていることを確認します。cp ~/ssl.cert $QUAY/config cp ~/ssl.key $QUAY/config cd $QUAY/config

$ cp ~/ssl.cert $QUAY/config $ cp ~/ssl.key $QUAY/config $ cd $QUAY/configCopy to Clipboard Copied! Toggle word wrap Toggle overflow config.yamlファイルを編集し、Quay で TLS を処理できるように指定します。config.yaml

... SERVER_HOSTNAME: quay-server.example.com ... PREFERRED_URL_SCHEME: https ...

... SERVER_HOSTNAME: quay-server.example.com ... PREFERRED_URL_SCHEME: https ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow Quayコンテナーを停止し、レジストリーを再起動します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4. UI を使用した SSL の設定

このセクションでは、Quay UI を使用して SSL を設定します。コマンドラインインターフェイスを使用して SSL を設定するには、以下のセクションを参照してください。

Quayコンテナーを設定モードで起動します。sudo podman run --rm -it --name quay_config -p 80:8080 -p 443:8443 registry.redhat.io/quay/quay-rhel8:v3.7.13 config secret

$ sudo podman run --rm -it --name quay_config -p 80:8080 -p 443:8443 registry.redhat.io/quay/quay-rhel8:v3.7.13 config secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

Server Configuration セクションで、TLS に

Red Hat Quay handle TLSを選択します。先に作成した証明書ファイルとプライベートキーファイルをアップロードし、証明書の作成時に Server Hostname が使用された値と一致することを確認します。更新された設定を検証およびダウンロードします。 Quayコンテナーを停止し、レジストリーを再起動します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5. コマンドラインを使用した SSL 設定のテスト

podman loginコマンドを使用して、SSL が有効になっている Quay レジストリーへのログインを試みます。sudo podman login quay-server.example.com Username: quayadmin Password: Error: error authenticating creds for "quay-server.example.com": error pinging docker registry quay-server.example.com: Get "https://quay-server.example.com/v2/": x509: certificate signed by unknown authority

$ sudo podman login quay-server.example.com Username: quayadmin Password: Error: error authenticating creds for "quay-server.example.com": error pinging docker registry quay-server.example.com: Get "https://quay-server.example.com/v2/": x509: certificate signed by unknown authorityCopy to Clipboard Copied! Toggle word wrap Toggle overflow Podman は自己署名証明書を信頼しません。回避策として、

--tls-verifyオプションを使用します。sudo podman login --tls-verify=false quay-server.example.com Username: quayadmin Password: Login Succeeded!

$ sudo podman login --tls-verify=false quay-server.example.com Username: quayadmin Password: Login Succeeded!Copy to Clipboard Copied! Toggle word wrap Toggle overflow

ルート認証局 (CA) を信頼するように Podman を設定する方法は、後続のセクションで説明します。

4.6. ブラウザーを使用した SSL 設定のテスト

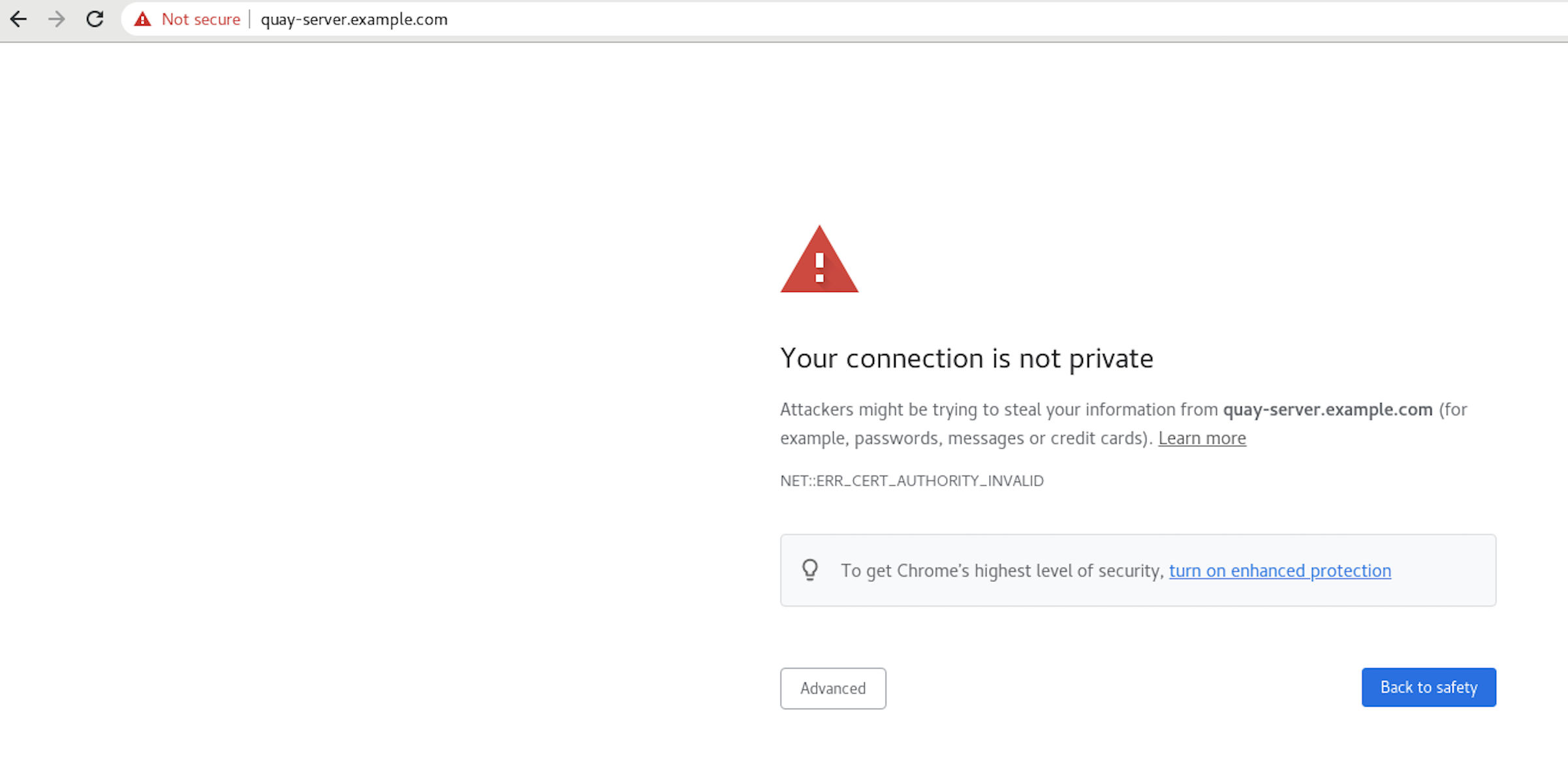

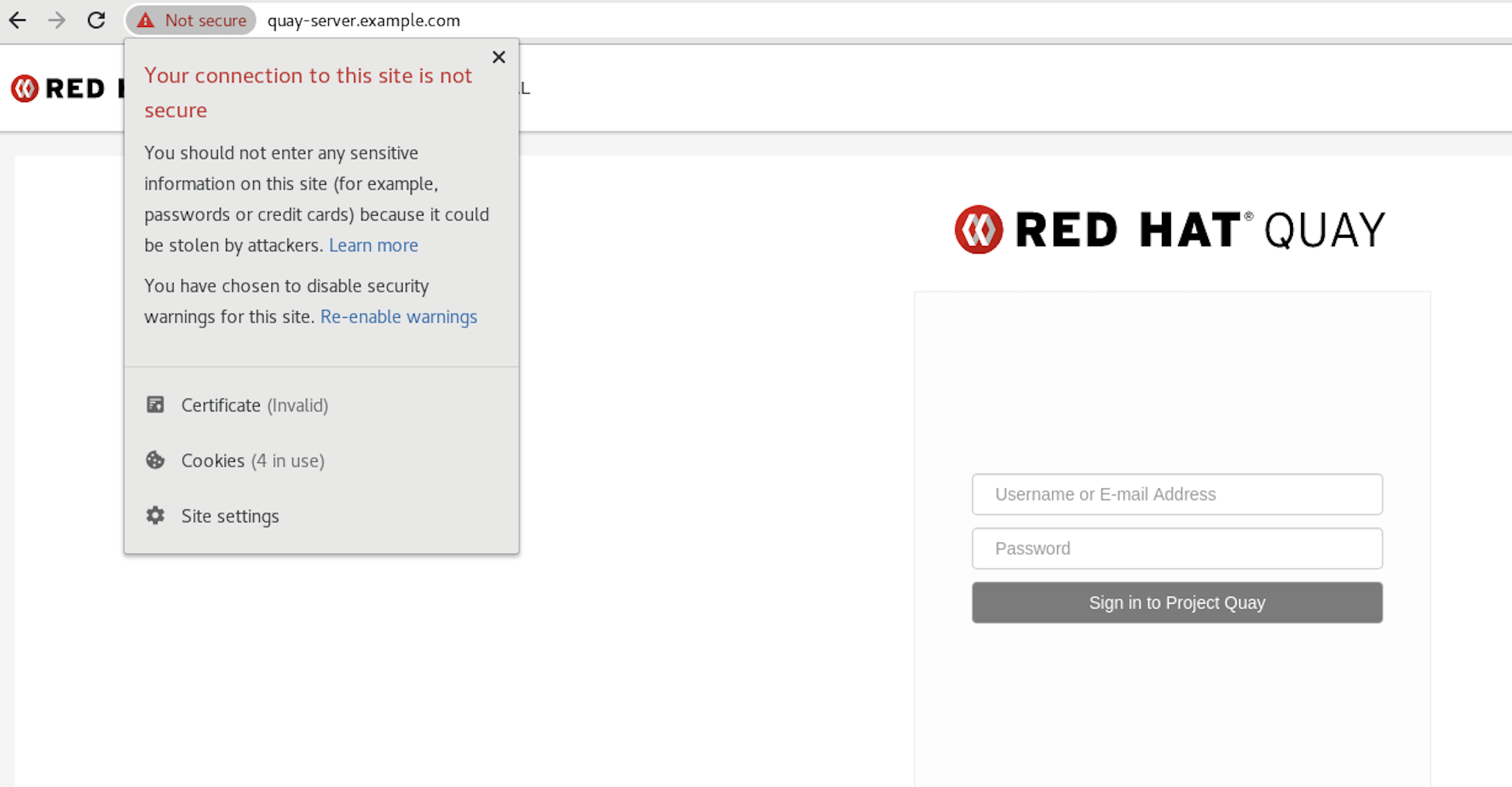

Quay レジストリーへのアクセスを試みると (この場合は https://quay-server.example.com)、ブラウザーは潜在的なリスクについて警告します。

画面にログインすると、ブラウザーは接続が安全ではないことを通知します。

ルート認証局 (CA) を信頼するようにシステムを設定する方法は、後続のセクションで説明します。

4.7. 認証局を信頼するように podman を設定する

Podman は、/etc/containers/certs.d/ および /etc/docker/certs.d/ の 2 つのパスを使用して CA ファイルを見つけます。

ルート CA ファイルをこれらの場所のいずれかにコピーし、サーバーのホスト名によって判別されるパスを使用して、

ca.crtファイルに名前を付けます。sudo cp rootCA.pem /etc/containers/certs.d/quay-server.example.com/ca.crt

$ sudo cp rootCA.pem /etc/containers/certs.d/quay-server.example.com/ca.crtCopy to Clipboard Copied! Toggle word wrap Toggle overflow または、Docker を使用している場合は、ルート CA ファイルを同等の Docker ディレクトリーにコピーします。

sudo cp rootCA.pem /etc/docker/certs.d/quay-server.example.com/ca.crt

$ sudo cp rootCA.pem /etc/docker/certs.d/quay-server.example.com/ca.crtCopy to Clipboard Copied! Toggle word wrap Toggle overflow

レジストリーにログインする際に、--tls-verify=false オプションを使用する必要がなくなります。

sudo podman login quay-server.example.com Username: quayadmin Password: Login Succeeded!

$ sudo podman login quay-server.example.com

Username: quayadmin

Password:

Login Succeeded!4.8. 認証局を信頼するようにシステムを設定

ルート CA ファイルを統合されたシステム全体のトラストストアにコピーします。

sudo cp rootCA.pem /etc/pki/ca-trust/source/anchors/

$ sudo cp rootCA.pem /etc/pki/ca-trust/source/anchors/Copy to Clipboard Copied! Toggle word wrap Toggle overflow システム全体のトラストストア設定を更新します。

sudo update-ca-trust extract

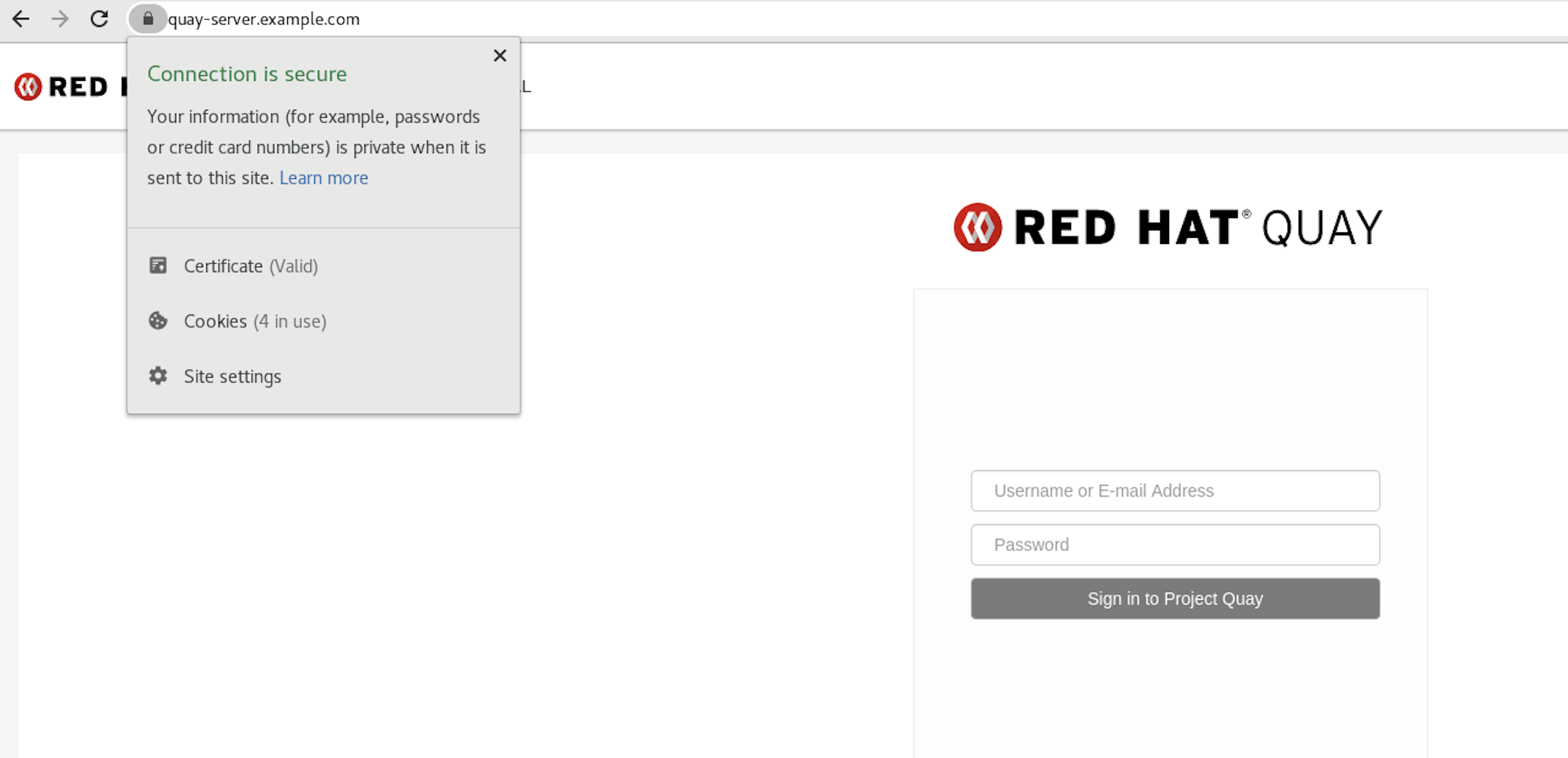

$ sudo update-ca-trust extractCopy to Clipboard Copied! Toggle word wrap Toggle overflow trust listコマンドを使用して、Quay サーバーが設定されていることを確認できます。trust list | grep quay label: quay-server.example.com$ trust list | grep quay label: quay-server.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow https://quay-server.example.comでレジストリーを参照すると、接続が安全であることを示すロックアイコンが表示されます。

システム全体の信頼からルート CA を削除するには、ファイルを削除し、設定を更新します。

sudo rm /etc/pki/ca-trust/source/anchors/rootCA.pem sudo update-ca-trust extract trust list | grep quay $

$ sudo rm /etc/pki/ca-trust/source/anchors/rootCA.pem $ sudo update-ca-trust extract $ trust list | grep quay $Copy to Clipboard Copied! Toggle word wrap Toggle overflow

詳細は、RHEL 8 のドキュメントの 共有システム証明書の使用 について参照してください。

第5章 Red Hat Quay コンテナーへの TLS 証明書の追加

カスタム TLS 証明書を Red Hat Quay に追加するには、Red Hat Quay の config ディレクトリーの下に extra_ca_certs/ という名前の新しいディレクトリーを作成します。必要なサイト固有の TLS 証明書をこの新しいディレクトリーにコピーします。

5.1. TLS 証明書を Red Hat Quay に追加

コンテナーに追加される証明書を表示します。

cat storage.crt -----BEGIN CERTIFICATE----- MIIDTTCCAjWgAwIBAgIJAMVr9ngjJhzbMA0GCSqGSIb3DQEBCwUAMD0xCzAJBgNV [...] -----END CERTIFICATE-----

$ cat storage.crt -----BEGIN CERTIFICATE----- MIIDTTCCAjWgAwIBAgIJAMVr9ngjJhzbMA0GCSqGSIb3DQEBCwUAMD0xCzAJBgNV [...] -----END CERTIFICATE-----Copy to Clipboard Copied! Toggle word wrap Toggle overflow certs ディレクトリーを作成し、そこに証明書をコピーします。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow QuayコンテナーのCONTAINER IDをpodman psで取得します。sudo podman ps CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS 5a3e82c4a75f <registry>/<repo>/quay:v3.7.13 "/sbin/my_init" 24 hours ago Up 18 hours 0.0.0.0:80->80/tcp, 0.0.0.0:443->443/tcp, 443/tcp grave_keller

$ sudo podman ps CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS 5a3e82c4a75f <registry>/<repo>/quay:v3.7.13 "/sbin/my_init" 24 hours ago Up 18 hours 0.0.0.0:80->80/tcp, 0.0.0.0:443->443/tcp, 443/tcp grave_kellerCopy to Clipboard Copied! Toggle word wrap Toggle overflow その ID でコンテナーを再起動します。

sudo podman restart 5a3e82c4a75f

$ sudo podman restart 5a3e82c4a75fCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンテナーの名前空間にコピーされた証明書を調べます。

sudo podman exec -it 5a3e82c4a75f cat /etc/ssl/certs/storage.pem -----BEGIN CERTIFICATE----- MIIDTTCCAjWgAwIBAgIJAMVr9ngjJhzbMA0GCSqGSIb3DQEBCwUAMD0xCzAJBgNV

$ sudo podman exec -it 5a3e82c4a75f cat /etc/ssl/certs/storage.pem -----BEGIN CERTIFICATE----- MIIDTTCCAjWgAwIBAgIJAMVr9ngjJhzbMA0GCSqGSIb3DQEBCwUAMD0xCzAJBgNVCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2. Kubernetes へのデプロイ時に証明書を追加

Kubernetes にデプロイすると、Red Hat Quay は config アセットを保存するボリュームとしてシークレットにマウントします。残念ながら、これは現在、スーパーユーザーパネルの証明書のアップロード機能に干渉します。

このエラーを回避するには、Red Hat Quay が展開された 後に base64 エンコードされた証明書をシークレットに追加します。以下に、実行する方法を説明します。

まず、証明書の内容を Base64 エンコードします。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow kubectlツールを使用して、quay-enterprise-config-secret を編集します。kubectl --namespace quay-enterprise edit secret/quay-enterprise-config-secret

$ kubectl --namespace quay-enterprise edit secret/quay-enterprise-config-secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow 証明書のエントリーを追加し、エントリーの下に base64 エンコードされた文字列を完全に貼り付けます。

custom-cert.crt: c1psWGpqeGlPQmNEWkJPMjJ5d0pDemVnR2QNCnRsbW9JdEF4YnFSdVd3PT0KLS0tLS1FTkQgQ0VSVElGSUNBVEUtLS0tLQo=

custom-cert.crt: c1psWGpqeGlPQmNEWkJPMjJ5d0pDemVnR2QNCnRsbW9JdEF4YnFSdVd3PT0KLS0tLS1FTkQgQ0VSVElGSUNBVEUtLS0tLQo=Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

最後に、すべての Red Hat Quay Pod をリサイクルします。

kubectl deleteを使用して、すべての Red Hat Quay Pod を削除します。Red Hat Quay Deployment は、新しい証明書データを使用して交換用 Pod を自動的にスケジュールします。

第6章 Elasticsearch のアクションログストレージの設定

デフォルトでは、過去 3ヶ月分の使用ログが Red Hat Quay データベースに保存され、組織レベルとリポジトリーレベルで Web UI を介して公開されます。ログエントリーを見るには、適切な管理者権限が必要です。大量の操作ログが記録されるデプロイメントでは、Red Hat Quay データベースバックエンドの代わりに Elasticsearch に使用ログを保存できるようになりました。これを行うには、独自の Elasticsearch スタックを用意する必要があります。これは、カスタマイズ可能なコンポーネントとして Red Hat Quay に含まれていないためです。

Elasticsearch のロギングを有効にするには、Red Hat Quay のデプロイ中、またはデプロイ後に Red Hat Quay Config Tool を使用して行うことができます。出来上がった設定は、config.yaml ファイルに格納されます。一度設定すれば、使用ログへのアクセスは、これまでと同様に、リポジトリーや組織の Web UI を介して提供されます。

ここでは、アクションログストレージをデフォルトの Red Hat Quay データベースから Elasticsearch を使用するように変更するための設定方法を説明します。

- Elasticsearch のアカウントを取得します。

- Red Hat Quay Config Tool を開きます (Red Hat Quay のデプロイ中またはデプロイ後)。

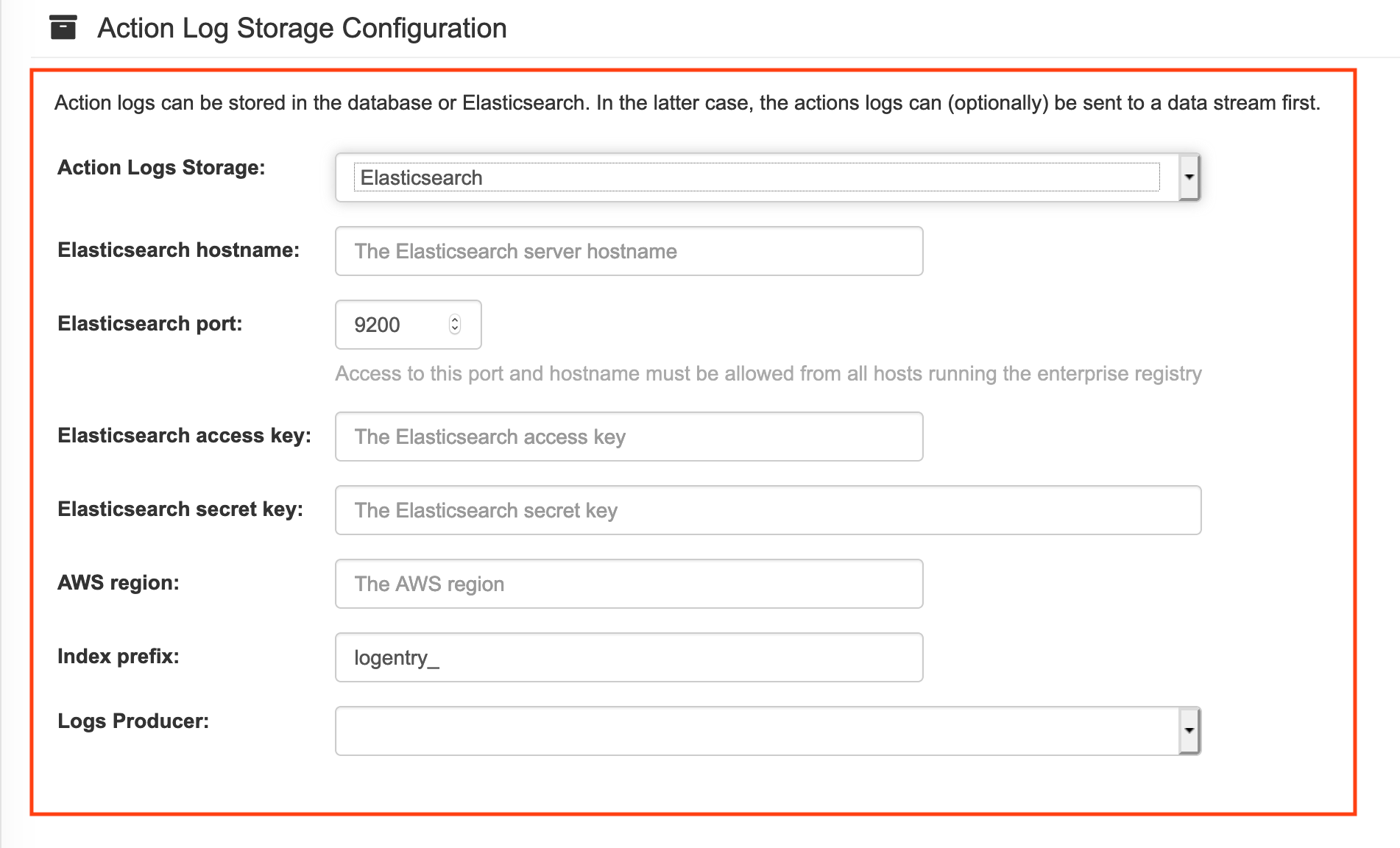

Action Log Storage Configuration 設定までスクロールし、Database の代わりに Elasticsearch を選択します。次の図は、表示される Elasticsearch の設定です。

使用する Elasticsearch インスタンスの以下の情報を入力します。

- Elasticsearch hostname: Elasticsearch サービスを提供するシステムのホスト名または IP アドレス。

- Elasticsearch port: 上で入力したホストで Elasticsearch サービスを提供しているポート番号。ポートが、Red Hat Quay レジストリーを実行しているすべてのシステムからアクセス可能でなければならないことに注意してください。デフォルトは TCP ポート 9200 です。

- Elasticsearch access key: 必要に応じて、Elasticsearch サービスにアクセスするために必要なアクセスキーです。

- Elasticsearch secret key: 必要に応じて、Elasticsearch サービスにアクセスするために必要な秘密鍵。

- AWS region: AWS 上で運用している場合は、AWS リージョンを設定します (そうでない場合は、空欄のままです)。

- Index prefix: ログエントリーに付ける接頭辞を選択します。

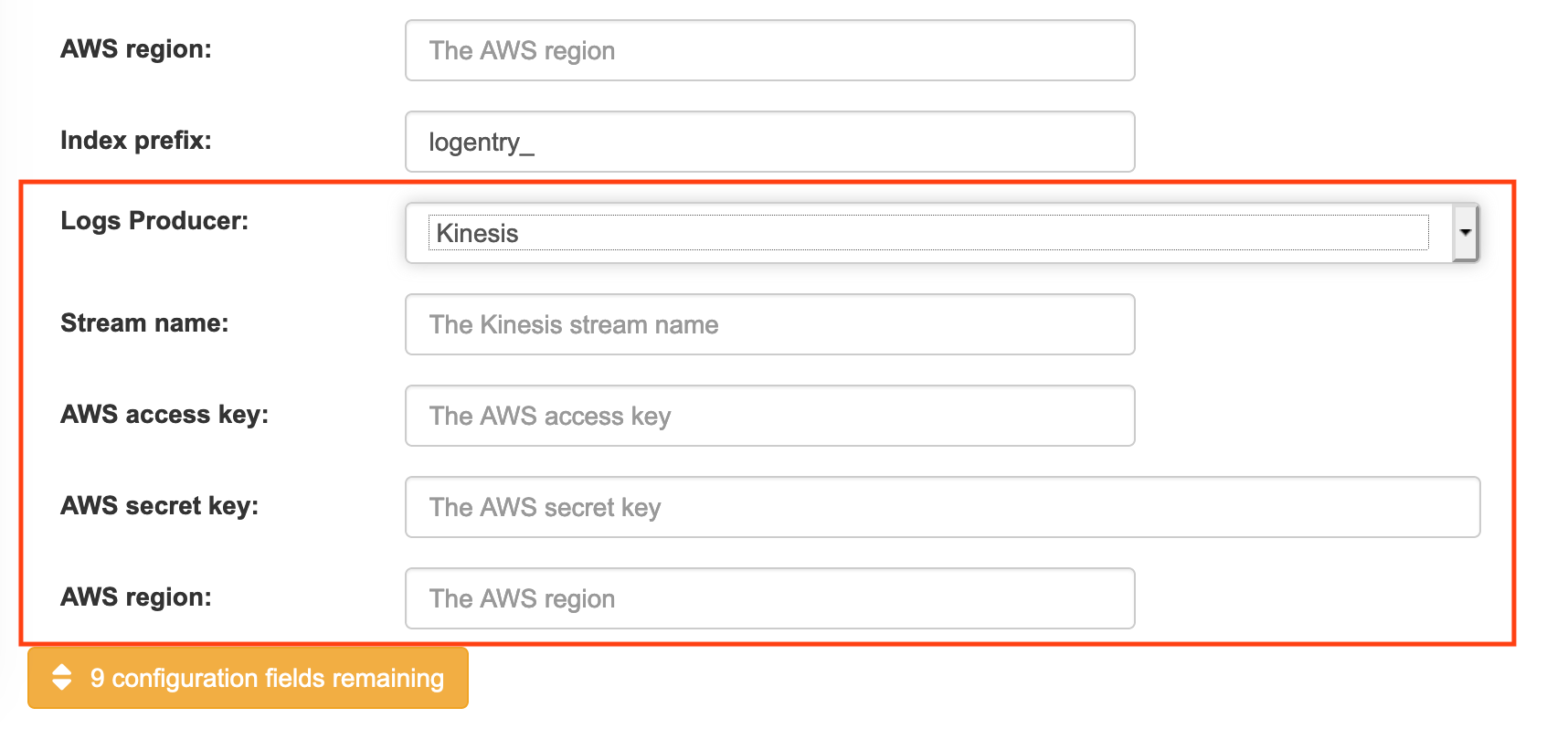

Logs Producer: Elasticsearch (デフォルト) または Kinesis のいずれかを選択し、ログを AWS 上の中間的な Kinesis ストリームに導きます。Kinesis から Elasticsearch (Logstash など) にログを送るには、独自のパイプラインを設定する必要があります。次の図は、Kinesis に必要な追加フィールドを示しています。

Logs Producer として Elasticsearch を選択した場合、これ以上の設定は必要ありません。Kinesis を選択した場合、以下を記入してください。

- ストリーム名: Kinesis のストリームの名前。

- AWS access key: Kinesis ストリームへのアクセスを得るために必要な AWS アクセスキーの名前 (必要な場合)。

- AWS secret key: Kinesis ストリームにアクセスするために必要な AWS シークレットキーの名前 (必要な場合)。

- AWS region: AWS のリージョン。

- 完了したら、設定を保存します。Config Tool が設定内容を検証します。Elasticsearch または Kinesis サービスへの接続に問題がある場合は、エラーが表示され、編集を続ける機会が与えられます。そうしないと、新しい設定に伴いでクラスターが再起動した後に、ロギングがあなたの Elasticsearch 設定に対して開始されます。

第7章 Clair セキュリティースキャン

Clair は、Red Hat Quay と共に使用できるマイクロサービスのセットで、一連の Linux オペレーティングシステムに関連付けられたコンテナーイメージの脆弱性スキャンを実行します。Clair のマイクロサービス設計は、エンタープライズ環境に合わせてコンポーネントを個別に拡張できるような、高いスケーラビリティーを持った設定で実行するのに適しています。

クレアは、以下の脆弱性データベースを利用して、お客様のイメージの問題点をスキャンします。

- アルパイン SecDB データベース

- AWS UpdateInfo

- Debian Oval データベース

- Oracle Oval データベース

- RHEL Oval データベース

- SUSE Oval データベース

- Ubuntu Oval データベース

- Pyup.io (python) データベース

Clair が異なるデータベースとのセキュリティーマッピングを行う方法については、ClairCore Severity Mapping を参照してください。

Red Hat Quay 3.4 のリリースに伴い、以前の Clair V2 (image quay.io/redhat/clair-jwt) が新しい Clair V4 (image registry.redhat.io/quay/clair-rhel8) に完全に置き換わりました。V4 の更新中に V2 をリードオンリーモードで動作させる方法は以下を参照してください。

7.1. Red Hat Quay OpenShift デプロイメントでの Clair の設定

7.1.1. Quay Operator によるデプロイ

OpenShift 上の新しい Red Hat Quay デプロイメントに Clair V4 をセットアップするには、Quay Operator を使用することを強くお勧めします。デフォルトでは、Quay Operator は、Red Hat Quay のデプロイとともに Clair のデプロイメントをインストールまたはアップグレードし、Clair のセキュリティースキャンを自動的に設定します。

7.1.2. 手動で Clair をデプロイ

Clair V2 を実行している既存の Red Hat Quay OpenShift デプロイメントに Clair V4 を設定するには、まず Red Hat Quay が少なくともバージョン 3.4.0 にアップグレードされていることを確認します。その後、以下の手順で Clair V4 を Clair V2 と一緒に手動で設定します。

現在のプロジェクトを、Red Hat Quay が実行されているプロジェクトの名前に設定します。以下に例を示します。

oc project quay-enterprise

$ oc project quay-enterpriseCopy to Clipboard Copied! Toggle word wrap Toggle overflow Clair v4 用の Postgres デプロイファイル (例:

clairv4-postgres.yaml) を以下のように作成します。clairv4-postgres.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のように、postgres データベースをデプロイします。

oc create -f ./clairv4-postgres.yaml

$ oc create -f ./clairv4-postgres.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Clair v4 で使用する Clair

config.yamlファイルを作成します。以下に例を示します。config.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Clair の PSK (pre-shared key) を生成するには、ユーザーインターフェイスの Security Scanner セクションで

scanningを有効にし、Generate PSKをクリックします。

Clair の設定フォーマットの詳細は、アップストリームの Clair ドキュメント に記載されています。

Clair の

config.yamlからシークレットを作成します。oc create secret generic clairv4-config-secret --from-file=./config.yaml

$ oc create secret generic clairv4-config-secret --from-file=./config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Clair v4 のデプロイメントファイル (例:

clair-combo.yaml) を作成し、必要に応じて修正します。clair-combo.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のように Clair v4 の配置を作成します。

oc create -f ./clair-combo.yaml

$ oc create -f ./clair-combo.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Quay 配置の

config.yamlファイルを変更して、最後に以下のエントリーを追加します。FEATURE_SECURITY_NOTIFICATIONS: true FEATURE_SECURITY_SCANNER: true SECURITY_SCANNER_V4_ENDPOINT: http://clairv4

FEATURE_SECURITY_NOTIFICATIONS: true FEATURE_SECURITY_SCANNER: true SECURITY_SCANNER_V4_ENDPOINT: http://clairv41 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Clair v4 サービスのエンドポイントの特定

修正した

config.yamlを、そのファイルを含むシークレット (たとえばquay-enterprise-config-secret) に再デプロイします。oc delete secret quay-enterprise-config-secret oc create secret generic quay-enterprise-config-secret --from-file=./config.yaml

$ oc delete secret quay-enterprise-config-secret $ oc create secret generic quay-enterprise-config-secret --from-file=./config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

新しい

config.yamlを有効にするには、Red Hat Quay の Pod を再起動する必要があります。quay-appの Pod を削除するだけで、更新された設定の Pod がデプロイされます。

この時点で、名前空間のホワイトリストで特定された組織のイメージは、Clair v4 によってスキャンされます。

7.2. OpenShift ではない Red Hat Quay のデプロイメントに Clair をセットアップ

OpenShift 上で稼働していない Red Hat Quay のデプロイメントでは、Clair のセキュリティースキャンを手動で設定することが可能です。すでに Clair V2 を実行している Red Hat Quay のデプロイメントは、以下の手順で Clair V4 をデプロイメントに追加することができます。

(フォールトトレラントが望ましい) Postgres データベースサーバーを導入します。なお、Clair は Postgres データベースに

uuid-osspエクステンションを追加する必要があります。Clair のconfig.yamlで指定されたユーザーが、拡張機能を作成するのに必要な権限を持っている場合は、Clair 自身によって自動的に追加されます。そうでない場合は、Clair を起動する前に拡張機能を追加する必要があります。この拡張子がない場合は、Clair を起動しようとすると以下のエラーが表示されます。ERROR: Please load the "uuid-ossp" extension. (SQLSTATE 42501)

ERROR: Please load the "uuid-ossp" extension. (SQLSTATE 42501)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 特定のフォルダーで Clair 設定ファイルを作成します (例:

/etc/clairv4/config/config.yaml)。config.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Clair の設定フォーマットの詳細は、アップストリームの Clair ドキュメント に記載されています。

コンテナーイメージ経由で Clair を実行し、作成したファイルから設定をマウントします。

podman run -p 8080:8080 -p 8089:8089 -e CLAIR_CONF=/clair/config.yaml -e CLAIR_MODE=combo -v /etc/clair4/config:/clair -d registry.redhat.io/quay/clair-rhel8:v3.7.13

$ podman run -p 8080:8080 -p 8089:8089 -e CLAIR_CONF=/clair/config.yaml -e CLAIR_MODE=combo -v /etc/clair4/config:/clair -d registry.redhat.io/quay/clair-rhel8:v3.7.13Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 新しい Clair V4 エンドポイントを使用するために Red Hat Quay を設定するには、前のセクションの残りの指示に従ってください。

この形で複数の Clair コンテナーを実行することも可能ですが、1 つのコンテナーを超えるデプロイメントシナリオでは、Kubernetes や OpenShift などのコンテナーオーケストレーターの使用を強く推奨します。

7.3. 高度な Clair 設定

7.3.1. 管理されていない Clair 設定

Red Hat Quay 3.7 を使用すると、ユーザーは Red Hat Quay OpenShift Container Platform Operator でアンマネージド Clair 設定を実行できます。この機能により、ユーザーはアンマネージド Clair データベースを作成したり、アンマネージドデータベースなしでカスタム Clair 設定を実行したりできます。

7.3.1.1. Clair データベースの管理を解除

アンマネージド Clair データベースにより、Red Hat Quay は geo-replicated environment で作業できます。この環境では、Operator の複数のインスタンスが同じデータベースと通信する必要があります。管理されていない Clair データベースは、ユーザーがクラスターの外部に存在する高可用性 (HA) Clair データベースを必要とする場合にも使用できます。

手順

Quay Operator で、QuayRegistry カスタムリソースの

clairpostgresコンポーネントを unmanaged に設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3.1.2. カスタム Clair データベースの設定

Red Hat Quay Operator for OpenShift Container Platform を使用すると、ユーザーは configBundleSecret パラメーターを編集して独自の Clair 設定を提供できます。

手順

clair-config.yamlを含む Quay 設定バンドルシークレットを作成します。oc create secret generic --from-file config.yaml=./config.yaml --from-file extra_ca_cert_rds-ca-2019-root.pem=./rds-ca-2019-root.pem --from-file clair-config.yaml=./clair-config.yaml --from-file ssl.cert=./ssl.cert --from-file ssl.key=./ssl.key config-bundle-secret

$ oc create secret generic --from-file config.yaml=./config.yaml --from-file extra_ca_cert_rds-ca-2019-root.pem=./rds-ca-2019-root.pem --from-file clair-config.yaml=./clair-config.yaml --from-file ssl.cert=./ssl.cert --from-file ssl.key=./ssl.key config-bundle-secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow clair-config.yaml設定の例:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記-

データベース証明書は、

clair-config.yamlの Clair アプリケーション Pod の/run/certs/rds-ca-2019-root.pemの下にマウントされます。clair-config.yamlを設定するときに指定する必要があります。 -

clair-config.yamlの例は、OpenShift 設定の Clair にあります。

-

データベース証明書は、

clair-config.yamlをconfigBundleSecretという名前のバンドルシークレットに追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記更新されると、提供された

clair-config.yamlが Clair Pod にマウントされます。提供されていないフィールドには、Clair 設定モジュールを使用してデフォルトが自動的に入力されます。

適切に設定した後、Clair アプリケーション Pod は Ready 状態に戻るはずです。

7.3.2. managed データベースを使用したカスタム Clair 設定の実行

場合によっては、ユーザーは managed データベースを使用してカスタム Clair 設定を実行したい場合があります。これは、以下のシナリオで役に立ちます。

- ユーザーがアップデーターを無効にしたい場合

ユーザーがエアギャップ環境で実行している場合

注記-

エアギャップ環境で Quay を実行している場合は、

clair-config.yamlのairgapパラメーターをtrueに設定する必要があります。 - エアギャップ環境で Quay を実行している場合は、すべてのアップデーターを無効にする必要があります。

-

エアギャップ環境で Quay を実行している場合は、

clairpostgres が managed に設定されている場合は、カスタム Clair データベースの設定の手順を使用してデータベースを設定します。

エアギャップ環境での Clair の実行の詳細は、エアギャップ OpenShift クラスターでの Clair データベースへのアクセスの設定 を参照してください。

7.4. Clair CRDA 設定

7.4.1. Clair CRDA の有効化

Java スキャンは、Code Ready Dependency Analytics (CRDA) と呼ばれる Red Hat が提供する公開 API サービスに依存しています。CRDA はインターネットアクセスでのみ使用でき、デフォルトでは有効になっていません。CRDA サービスをカスタム API キーと統合し、CRDA for Java および Python スキャンを有効にするには、次の手順に従います。

前提条件

- Red Hat Quay 3.7 以降

手順

- API キーリクエストフォーム を送信して、Quay 固有の CRDA リモートマッチャーを取得します。

clair-config.yamlファイルで CRDA 設定を設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- この API キーリクエストフォーム から Quay 固有の CRDA リモートマッチャーを挿入します。

- 2

- Quay サーバーのホスト名。

7.5. クレールの使用

- Red Hat Quay クラスターにログインし、Clair スキャンを設定した組織を選択します。

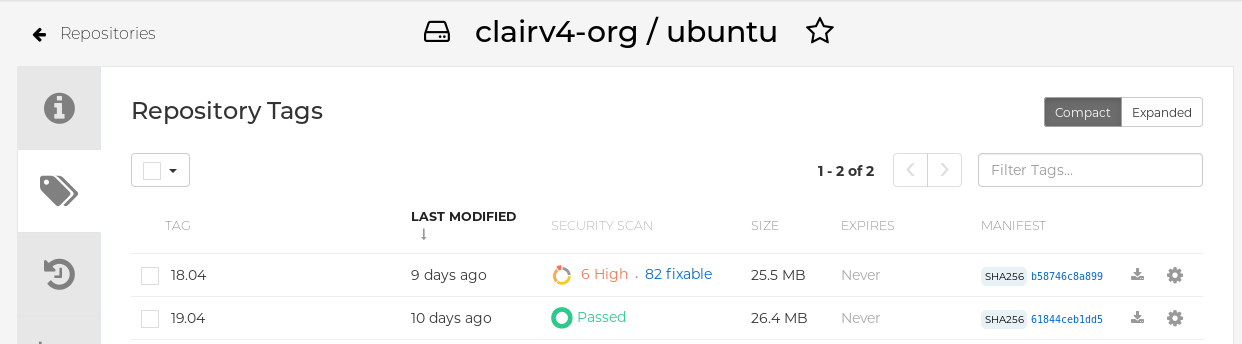

その組織からいくつかのイメージを保持するリポジトリーを選択し、左のナビゲーションからタグを選択します。次の図は、2 枚のイメージがスキャンされたリポジトリーの例です。

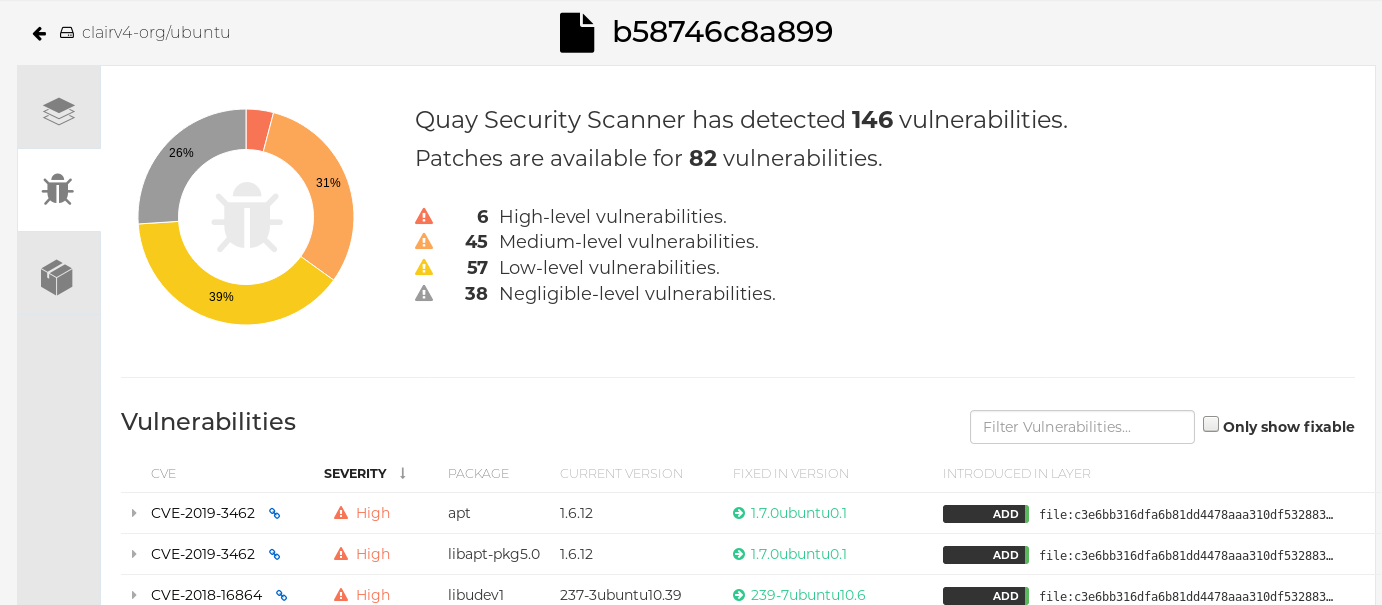

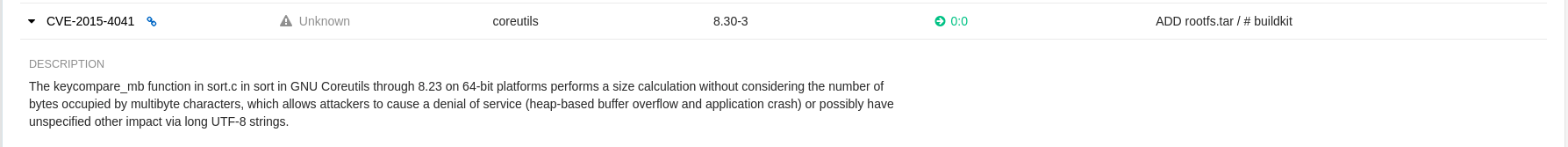

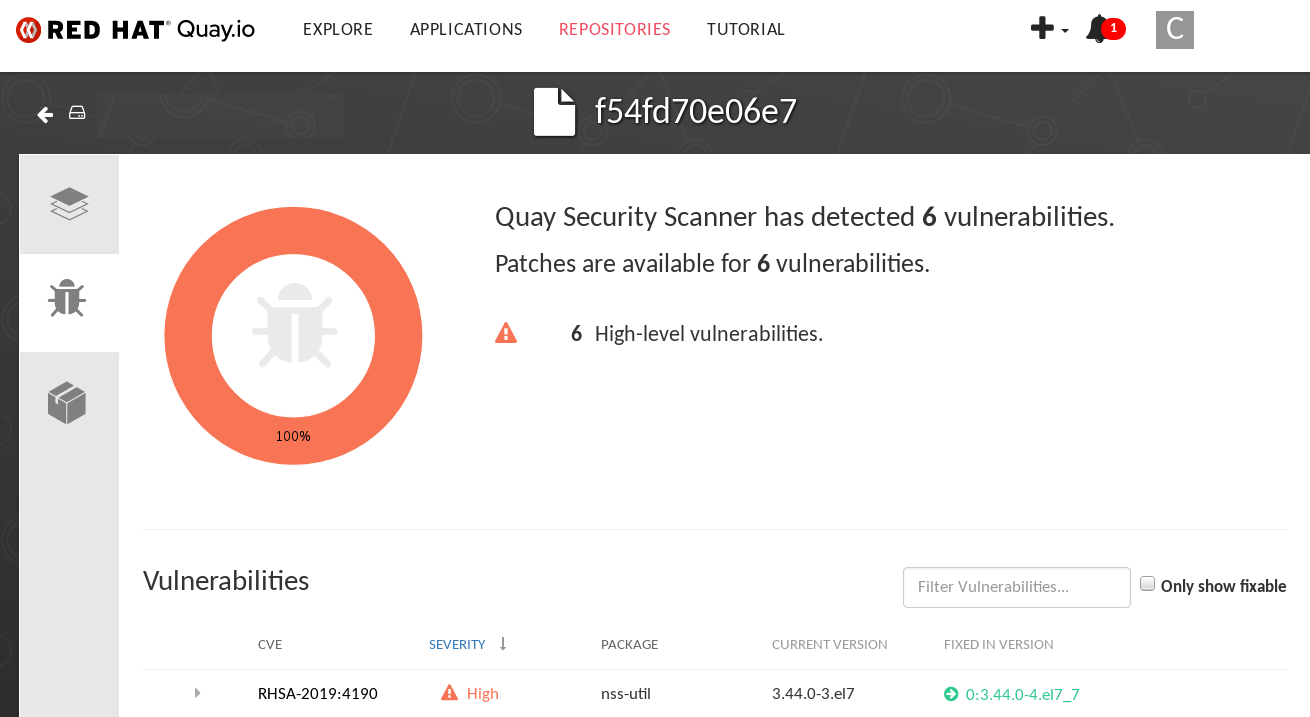

脆弱性が発見された場合は、イメージのセキュリティースキャン欄を選択すると、すべての脆弱性または修正可能な脆弱性が表示されます。次の図は、見つかったすべての脆弱性の情報を示しています。

7.6. 脆弱性情報データベース (NVD: National Vulnerability Database) の CVE 評価

Clair v4.2 では、エンリッチメントデータを Quay UI で表示できるようになりました。さらに、Clair v4.2 は、検出された脆弱性について National Vulnerability Database から CVSS スコアを追加します。

この変更により、脆弱性の CVSS スコアがディストリビューションのスコアの 2 レベル以内である場合は、デフォルトで Quay UI present が、ディストリビューションのスコアになります。以下に例を示します。

これは以前のインターフェイスとは異なり、以下の情報のみを表示します。

7.7. 切断された環境のための Clair の設定

Clair は、アップデータと呼ばれる一連のコンポーネントを利用して、様々な脆弱性データベースからのデータのフェッチとパースを処理します。これらのアップデータは、インターネットから直接脆弱性データを取得するようにデフォルトで設定されており、すぐに使用することができます。インターネットに直接アクセスできない切断された環境にいるお客様にとっては、これは問題となります。クレアは、ネットワークの分離を考慮した様々なタイプの更新ワークフローに対応することで、これらの環境をサポートします。clairctl コマンドラインユーティリティーを使用すると、どのプロセスでも、オープンホスト経由でインターネットからアップデータを取得し、そのデータを隔離されたホストに安全に転送し、隔離されたホスト上のアップデータを Clair 本体にインポートすることが簡単にできます。

その手順は以下の通りです。

まず、Clair の設定で、自動化されたアップデータの実行が無効になっていることを確認してください。

config.yaml

matcher: disable_updaters: true

matcher: disable_updaters: trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 最新のアップデータをローカルのアーカイブに書き出します。このためには、バイナリーとして直接実行するか、Clair コンテナーイメージを介して実行できる

clairctlツールが必要です。Clair の設定が/etc/clairv4/config/config.yamlにあり、コンテナーイメージ経由で実行できるとします。podman run -it --rm -v /etc/clairv4/config:/cfg:Z -v /path/to/output/directory:/updaters:Z --entrypoint /bin/clairctl registry.redhat.io/quay/clair-rhel8:v3.7.13 --config /cfg/config.yaml export-updaters /updaters/updaters.gz

$ podman run -it --rm -v /etc/clairv4/config:/cfg:Z -v /path/to/output/directory:/updaters:Z --entrypoint /bin/clairctl registry.redhat.io/quay/clair-rhel8:v3.7.13 --config /cfg/config.yaml export-updaters /updaters/updaters.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow なお、Clair の設定を細かく参照する必要があります。これにより、

/etc/clairv4/updaters/updaters.gzにアップデーターのアーカイブが作成されます。ソースデータベースからエラーなしにアーカイブが作成されたことを確認する場合は、--strictフラグをclairctlに指定できます。アーカイブファイルは、Clair を起動している切断されたホストからアクセス可能なボリュームにコピーしてください。切断されたホストから、今度は同じ手順で Clair にアーカイブをインポートします。podman run -it --rm -v /etc/clairv4/config:/cfg:Z -v /path/to/output/directory:/updaters:Z --entrypoint /bin/clairctl registry.redhat.io/quay/clair-rhel8:v3.7.13 --config /cfg/config.yaml import-updaters /updaters/updaters.gz

$ podman run -it --rm -v /etc/clairv4/config:/cfg:Z -v /path/to/output/directory:/updaters:Z --entrypoint /bin/clairctl registry.redhat.io/quay/clair-rhel8:v3.7.13 --config /cfg/config.yaml import-updaters /updaters/updaters.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.7.1. リポジトリーの Common Product Enumeration (CPE) 情報へのマッピング

Clair の RHEL スキャナーは、一致する結果を生成するために、Common Product Enumeration (CPE) ファイルに依存して RPM パッケージを対応するセキュリティーデータに適切にマッピングします。スキャナーが RPM を適切に処理するには、このファイルが存在するか、ファイルへのアクセスが許可されている必要があります。ファイルが存在しない場合、コンテナーイメージにインストールされている RPM はスキャンされません。

Red Hat は、JSON マッピングファイルを https://www.redhat.com/security/data/metrics/repository-to-cpe.json で公開しています。

非接続 Clair のデータベースに CVE 情報をアップロードする以外に、マッピングファイルをローカルで利用可能にする必要もあります。

- スタンドアロン Quay および Clair デプロイメントの場合は、マッピングファイルを Clair Pod に読み込む必要があります。

-

Operator ベースのデプロイメントの場合は、Clair コンポーネントを

unmanagedに設定する必要があります。次に、Clair を手動でデプロイし、マッピングファイルのローカルコピーを読み込むように設定します。

Clair 設定の repo2cpe_mapping_file フィールドを使用してファイルを指定します。

indexer:

scanner:

repo:

rhel-repository-scanner:

repo2cpe_mapping_file: /path/to/repository-to-cpe.json

indexer:

scanner:

repo:

rhel-repository-scanner:

repo2cpe_mapping_file: /path/to/repository-to-cpe.json詳細は、Red Hat の How to accurately match OVAL security data to installed RPMs を参照してください。

7.8. Clair アップデーター URL

以下は、Clair がデフォルト設定で対話を試みる HTTP ホストおよびパスです。一部のサーバーではリダイレクトが実行されたり、一部の要求 URL は動的に構築されるため、この一覧はすべてを網羅している訳ではありません。

- https://secdb.alpinelinux.org/

- http://repo.us-west-2.amazonaws.com/2018.03/updates/x86_64/mirror.list

- https://cdn.amazonlinux.com/2/core/latest/x86_64/mirror.list

- https://www.debian.org/security/oval/

- https://linux.oracle.com/security/oval/

- https://packages.vmware.com/photon/photon_oval_definitions/

- https://github.com/pyupio/safety-db/archive/

- https://catalog.redhat.com/api/containers/

- https://www.redhat.com/security/data/

- https://support.novell.com/security/oval/

- https://people.canonical.com/~ubuntu-security/oval/

7.9. 追加情報

マイクロサービスがどのように設定されているかなど、Clair の内部に関する詳細なドキュメントは、Upstream Clair および ClairCore のドキュメントを参照してください。

第8章 コンテナーセキュリティー Operator での Pod イメージのスキャン

Container Security Operator (CSO) は、OpenShift Container Platform およびその他の Kubernetes プラットフォームで利用可能な Clair セキュリティースキャナーのアドオンです。CSO を使用すると、ユーザーはアクティブな Pod に関連付けられているコンテナーイメージをスキャンして、既知の脆弱性を見つけることができます。

CSO は、Red Hat Quay と Clair なしでは機能しません。

Container Security Operator (CSO) は、次の機能を実行します。

- 指定された namespace またはすべての namespace の Pod に関連付けられたコンテナーを監視します。

- コンテナーのソースであるコンテナーレジストリーにクエリーを実行して、脆弱性情報を取得します (イメージのレジストリーが、Clair スキャンを使用する Red Hat Quay レジストリーなどのイメージスキャンをサポートしている場合)。

-

Kubernetes API の

ImageManifestVulnオブジェクトを使用して脆弱性を公開します。

CSO を Kubernetes にインストールする手順を見るには、Container Security OperatorHub.io のページから Install ボタンを選択します。

8.1. OpenShift Container Platform での Container Security Operator のダウンロードおよび実行

次の手順を使用して、Container Security Operator をダウンロードします。

次の手順では、CSO を marketplace-operators namespace にインストールします。これにより、OpenShift Container Platform クラスターのすべての namespace で CSO を使用できるようになります。

-

Operators → OperatorHub (Security を選択) で、利用可能な

Container SecurityOperator が表示されます。 -

Container SecurityOperator を選択し、Installを選択して Create Operator Subscription ページに移動します。 -

設定 (デフォルトでは、全ネームスペースと自動承認戦略) を確認し、

Subscribeを選択します。しばらくすると、Installed Operators画面にContainer Securityが表示されます。 必要に応じて、カスタム証明書を CSO に追加できます。以下の例では、現在のディレクトリーに quay.crt という名前の証明書を作成します。その後、次のコマンドを実行して、CSO に証明書を追加します (新しい証明書を有効にするために、Operator Pod を再起動します)。

oc create secret generic container-security-operator-extra-certs --from-file=quay.crt -n openshift-operators

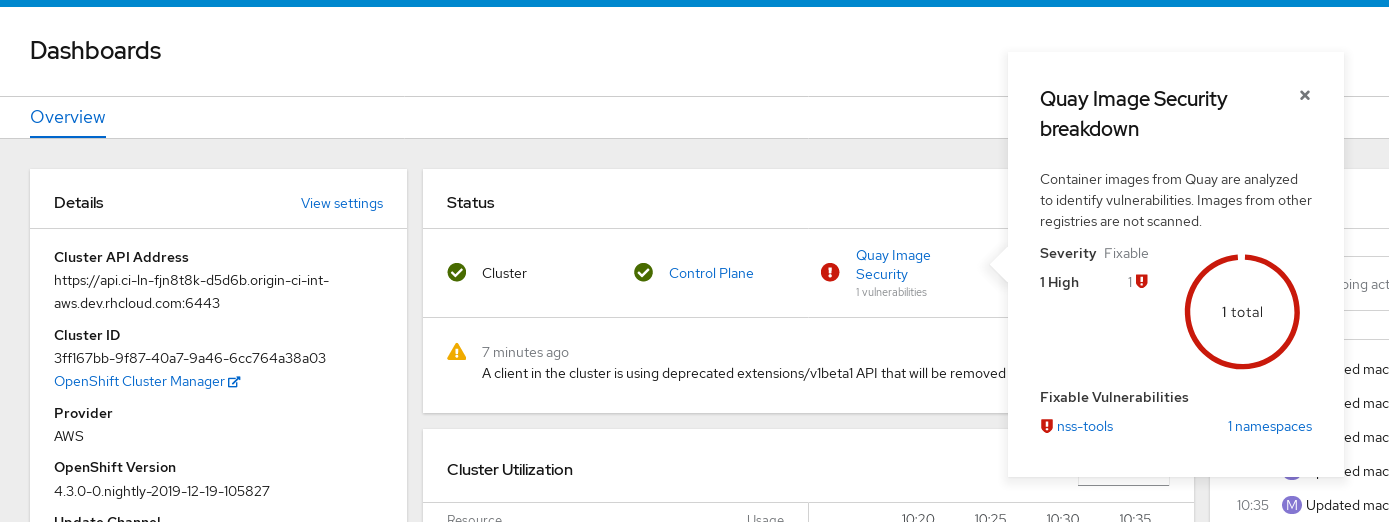

$ oc create secret generic container-security-operator-extra-certs --from-file=quay.crt -n openshift-operatorsCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Dashboard を開きます (Home → Dashboards)。Image Security へのリンクが status セクションに表示され、これまでに見つかった脆弱性の数の一覧が表示されます。リンクを選択すると、次の図のようにセキュリティーの内訳が表示されます。

この時点で、検出された脆弱性をフォローするために以下の 2 つのいずれかの操作を実行できます。

脆弱性へのリンクを選択します。コンテナーのレジストリー、Red Hat Quay、またはコンテナーを取得したその他のレジストリーに移動し、脆弱性に関する情報が表示されます。以下の図は、Quay.io レジストリーから検出された脆弱性の例を示しています。

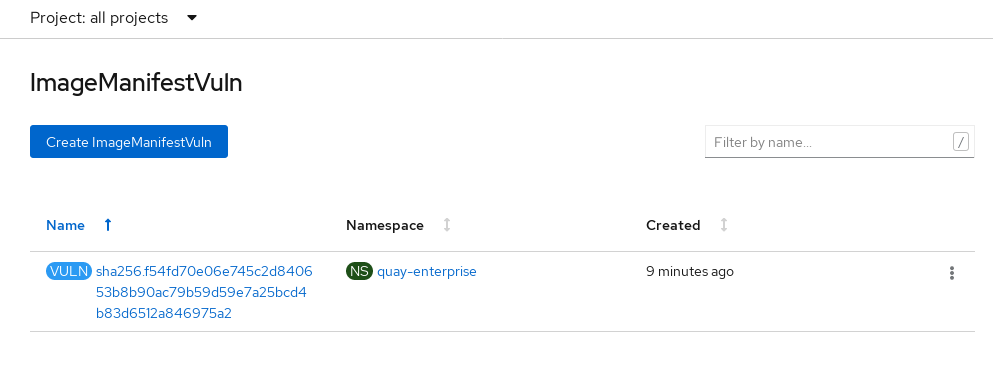

namespaces のリンクを選択すると、ImageManifestVuln 画面が表示され、選択したイメージの名前と、そのイメージが実行されているすべてのネームスペースが表示されます。以下の図は、特定の脆弱なイメージが 2 つの namespace で実行されていることを示しています。

この時点では、脆弱性のあるイメージや、イメージの脆弱性を解決するために必要なこと、およびイメージが実行されたすべての namespace を確認できます。以下を実行することができます。

- 脆弱性を修正する必要のあるイメージを実行しているユーザーに警告します。

- イメージが置かれている Pod を起動したデプロイメントまたは他のオブジェクトを削除して、イメージの実行を停止します。

なお、Pod を削除した場合は、ダッシュボード上で脆弱性がリセットされるまでに数分かかることがあります。

8.2. CLI からイメージの脆弱性を問い合わせ

コマンドラインからセキュリティーに関する情報を照会することができます。検出された脆弱性を照会するには、次のように入力します。

oc get vuln --all-namespaces NAMESPACE NAME AGE default sha256.ca90... 6m56s skynet sha256.ca90... 9m37s

$ oc get vuln --all-namespaces

NAMESPACE NAME AGE

default sha256.ca90... 6m56s

skynet sha256.ca90... 9m37s

特定の脆弱性の詳細を表示するには、脆弱性の 1 つを特定し、その名前空間および describe オプションを指定します。以下の例は、イメージに脆弱性のある RPM パッケージが含まれるアクティブなコンテナーを示しています。

第9章 Quay Bridge Operator を使用した OpenShift Container Platform の Red Hat Quay への統合

Quay Bridge Operator を使用すると、Red Hat Quay の統合コンテナーレジストリーを OpenShift Container Platform レジストリーに置き換えることができます。これを実行することにより、統合 OpenShift コンテナープラットフォームレジストリーは、強化された RBAC(ロールベースアクセス制御) 機能を備えた可用性の高い、エンタープライズレベルの Red Hat Quay レジストリーになります。

Quay Bridge Operator の主な目標は、統合された OpenShift Container Platform レジストリーの機能を新しい Red Hat Quay レジストリーに複製することです。Quay Bridge Operator で有効になる機能は次のとおりです。

- OpenShift Container Platform namespace を Red Hat Quay 組織として同期します。

- 各デフォルト namespace サービスアカウント用のロボットアカウントの作成。

-

作成された各ロボットアカウントのシークレットの作成 (各ロボットシークレットを

MountableImage Pull Secretとしてサービスアカウントに関連付ける) - OpenShift Container Platform イメージストリームを Red Hat Quay リポジトリーとして同期します。

- Red Hat Quay への出力に ImageStream を使用した新規ビルドの自動再作成

- ビルド完了後の image stream タグの自動インポート

以下の手順を使用することにより、Red Hat Quay と OpenShift Container Platform クラスター間の双方向通信を有効にします。

9.1. Quay Bridge Operator 用の Red Hat Quay のセットアップ

この手順では、専用の Red Hat Quay 組織を作成し、その組織内で作成された新しいアプリケーションから、OpenShift Container Platform の OpenShift Container Platform で使用される OAuth トークンを生成します。

手順

- WebUI を介して Red Hat Quay にログインします。

- 外部アプリケーションを設定する組織を選択します。

- ナビゲーションペインで、Applications を選択します。

-

Create New Application を選択し、新規アプリケーションの名前を入力します (例:

openshift)。 -

OAuth Applications ページで、アプリケーション (

openshiftなど) を選択します。 - ナビゲーションペインで、Generate Token を選択します。

次のフィールドを選択します。

- Administer Organization

- Administer Repositories

- Create Repositories

- View all visible repositories

- Read/Write to any accessible repositories

- Administer User

- Read User Information

- 割り当てられた権限を確認します。

- Authorize Application を選択し、Authorize Application を選択して認証を確認します。

生成されたアクセストークンを保存します。

重要Red Hat Quay はトークン管理を提供しません。トークンを一覧表示したり、トークンを削除したり、トークンを変更したりすることはできません。生成されたアクセストークンは 1 回だけ表示され、ページを閉じた後に再取得することはできません。

9.2. OpenShift Container Platform への OpenShift Container Platform のインストール

この手順では、Quay Bridge Operator を OpenShift Container Platform にインストールします。

前提条件

- Red Hat Quay をセットアップし、アクセストークンを取得した。

- クラスター管理者権限を持っている OpenShift Container Platform 4.6 の環境。

手順

- Web コンソールの Administrator パースペクティブを開き、ナビゲーションペインで Operator → OperatorHub に移動します。

-

Quay Bridge Operatorを検索し、Quay Bridge Operator のタイトルをクリックして、Install をクリックします。 - インストールするバージョン (たとえば、stable-3.7) を選択し、Install をクリックします。

- インストールが完了したら、View Operator をクリックして、Quay Bridge Operator の Details ページに移動します。または、Installed Operators → Red Hat Quay Bridge Operator をクリックして、Details ページに移動することもできます。

9.3. OAuth トークンの OpenShift Container Platform シークレットの作成

この手順では、以前に取得したアクセストークンを追加して、Red Hat Quay デプロイメントと通信します。アクセストークンは、OpenShift Container Platform 内にシークレットとして保存されます。

前提条件

- Red Hat Quay をセットアップし、アクセストークンを取得しました。

- OpenShift Container Platform に OpenShift Container Platform をデプロイしました。

- クラスター管理者権限を持っている OpenShift Container Platform 4.6 の環境。

- OpenShift CLI (oc) がインストールされている。

手順

openshift-operatorsnamespace にアクセストークンを含むシークレットを作成します。oc create secret -n openshift-operators generic <secret-name> --from-literal=token=<access_token>

$ oc create secret -n openshift-operators generic <secret-name> --from-literal=token=<access_token>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

9.4. QuayIntegration カスタムリソースの作成

この手順では、QuayIntegration カスタムリソースを作成します。これは、Web コンソールまたはコマンドラインから実行できます。

前提条件

- Red Hat Quay をセットアップし、アクセストークンを取得しました。

- OpenShift Container Platform に OpenShift Container Platform をデプロイしました。

- クラスター管理者権限を持っている OpenShift Container Platform 4.6 の環境。

- オプション: OpenShift CLI (oc) をインストールしました。

9.4.1. オプション: CLI を使用して QuayIntegration カスタムリソースを作成する

この手順に従って、コマンドラインを使用して QuayIntegration カスタムリソースを作成します。

手順

quay-integration.yamlを作成します:touch quay-integration.yaml

$ touch quay-integration.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow QuayIntegrationカスタムリソースの最小限のデプロイメントには、次の設定を使用します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow すべての設定フィールドのリストについては、QuayIntegration configuration fields を参照してください。

QuayIntegrationカスタムリソースを作成します。oc create -f quay-integration.yaml

$ oc create -f quay-integration.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

9.4.2. オプション:Web コンソールを使用して QuayIntegration カスタムリソースを作成する

この手順に従って、Web コンソールを使用して QuayIntegration カスタムリソースを作成します。

手順

- Web コンソールの Administrator パースペクティブを開き、Operators → Installed Operators に移動します。

- Red Hat Quay Bridge Operator をクリックします。

- Quay Bridge Operator の Details ページで、Quay Integration API カードの Create Instance をクリックします。

Create QuayIntegration ページで、Form view または YAML view のいずれかに以下の必須情報を入力します。

-

Name:

QuayIntegrationカスタムリソースオブジェクトを参照する名前。 -

Cluster ID: このクラスターに関連付けられている ID。この値は、エコシステム全体で一意である必要があります。指定しない場合、デフォルトで

openshiftになります。 - Credentials secret: 以前に作成されたトークンを含むシークレットの名前空間と名前を参照します。

Quay hostname: Quay レジストリーのホスト名。

すべての設定フィールドのリストについては、QuayIntegration configuration fields を参照してください。

-

Name:

QuayIntegration カスタムリソースが作成されると、OpenShift Container Platform クラスターが Red Hat Quay インスタンスにリンクされます。Red Hat Quay レジストリー内の組織は、OpenShift Container Platform 環境の関連する namespace 用に作成する必要があります。

9.5. QuayIntegration 設定フィールド

QuayIntegration カスタムリソースでは、次の設定フィールドを使用できます。

| 名前 | 説明 | スキーマ |

|---|---|---|

|

allowlistNamespaces | 含める namespace のリスト。 | Array |

|

clusterID | このクラスターに関連付けられている ID。 | 文字列 |

|

credentialsSecret.key | Quay レジストリーと通信するための資格情報を含む秘密。 | オブジェクト |

|

denylistNamespaces | 除外する namespace のリスト。 | Array |

|

insecureRegistry | Quay レジストリーへの TLS 検証をスキップするかどうか | ブール値 |

|

quayHostname | Quay レジストリーのホスト名。 | 文字列 |

|

scheduledImageStreamImport | イメージストリームのインポートを有効にするかどうか。 | ブール値 |

第10章 リポジトリーのミラーリング

10.1. リポジトリーのミラーリング

Red Hat Quay リポジトリーミラーリングを使用すると、外部コンテナーレジストリー (または別のローカルレジストリー) から Red Hat Quay クラスターにイメージをミラーリングできます。リポジトリーミラーリングを使用すると、リポジトリー名とタグに基づいてイメージを Red Hat Quay に同期できます。

リポジトリーミラーリングが有効にされた Red Hat Quay クラスターから、以下を実行できます。

- 外部のレジストリーからミラーリングするリポジトリーを選択する。

- 外部レジストリーにアクセスするための認証情報を追加する。

- 同期する特定のコンテナーイメージリポジトリー名とタグを特定する。

- リポジトリーが同期される間隔を設定する。

- 同期の現在の状態を確認する。

ミラーリング機能を使用するには、以下を行う必要があります。

- Red Hat Quay 設定でリポジトリーのミラーリングを有効にします。

- リポジトリーミラーリングワーカーを実行する。

- ミラーリングされたリポジトリーを作成します。

すべてのリポジトリーミラーリングの設定は、コンフィグレーションツールの UI または Red Hat Quay API を使用して行うことができます。

10.2. リポジトリーのミラーリングと geo レプリケーションの比較

Red Hat Quay の geo レプリケーションは、データベースが共有されている間に、2 つ以上の異なるストレージバックエンド間でイメージストレージのバックエンドデータ全体をミラーリングします (2 つの異なる blob ストレージエンドポイントを持つ 1 つの Red Hat Quay レジストリー)。geo レプリケーションの主なユースケースは以下のとおりです。

- 地理的に分散する設定向けのバイナリー Blob へのアクセス速度を上げる

- イメージのコンテンツがリージョン全体で同じであることを保証する

リポジトリーのミラーリングは、選択されたリポジトリー (またはリポジトリーのサブセット) をあるレジストリーから別のレジストリーに同期します。レジストリーは固有であり、各レジストリーには個別のデータベースおよび個別のイメージストレージがあります。ミラーリングの主なユースケースは、以下のとおりです。

- 異なるデータセンターまたはリージョンでの独立したレジストリーのデプロイメント。ここでは、すべてのコンテンツの特定のサブセットがデータセンター/リージョン間で共有されることになっています。

- 外部レジストリーからローカル Red Hat Quay デプロイメントへの選択された (ホワイトリスト化された) アップストリームリポジトリーの自動同期またはミラーリング。

リポジトリーのミラーリングと Geo レプリケーションを同時に使用できます。

| 機能と性能 | Geo レプリケーション | リポジトリーのミラーリング |

|---|---|---|

| 設計されている機能 | グローバルに共有されるレジストリー | 独立した異なるレジストレーション |

| レプリケーションやミラーリングがまだ完了していない場合はどうなるか ? | リモートコピーを使用する (遅くなります) | イメージが表示されない |

| 両地域のすべてのストレージバックエンドへのアクセスが必要か ? | はい (すべての Red Hat Quay ノード)。 | いいえ (個別のストレージ) |

| ユーザーは両方のサイトのイメージを同じリポジトリーにプッシュできるか ? | はい | いいえ |

| すべてのレジストリーの内容と設定がすべての地域で同一であるか (共有データベース) | はい | いいえ |

| ユーザーはミラーリングする個別の namespace またはリポジトリーを選択できるか ? | いいえ | はい |

| ユーザーは同期ルールにフィルターを適用できるか ? | いいえ | はい |

| 各リージョンで許可されている個別/異なる RBAC 設定か ? | いいえ | はい |

10.3. リポジトリーミラーリングの使用

ここでは、Red Hat Quay リポジトリーミラーリングの機能と制限について説明します。

- リポジトリーのミラーリングでは、リポジトリー全体をミラーリングしたり、同期するイメージを選択的に制限したりできます。フィルターは、タグのコンマ区切りの一覧、タグの範囲、または正規表現でタグを特定する他の方法によります。

- ミラーリングされたリポジトリーとして設定されると、そのリポジトリーに他のイメージを手動で追加することはできません。

- ミラーリングされたリポジトリーは設定するリポジトリーとタグをベースとするため、そのリポジトリー/タグのペアで表されるコンテンツのみを保持します。つまり、リポジトリーの一部のイメージがこれ以上一致しないようにタグを変更すると、これらのイメージは削除されます。

- 指定されたロボットだけが、ミラーリングされたリポジトリーにイメージをプッシュすることができ、リポジトリーに設定されたロールベースのアクセスコントロール権限に優先します。

- ミラーリングされたリポジトリーを使用すると、ユーザーはリポジトリーからイメージをプルできますが (読み取りパーミッションが付与される)、イメージをリポジトリーにプッシュすることはできません。

- ミラーリングされたリポジトリーの設定の変更は、作成するミラーリングされたリポジトリーの Repositories → Mirrors タブを使用して Red Hat Quay UI で実行できます。

- イメージは一定の間隔で同期されますが、必要に応じて同期することもできます。

10.4. 設定のミラーリング UI

設定モードで

Quayコンテナーを起動し、Enable Repository Mirroring チェックボックスを選択します。HTTPS 通信を必要とし、ミラーリング時に証明書を検証する必要がある場合は、HTTPS を選択し、証明書の検証のチェックボックスを選択します。

-

configurationを検証し、ダウンロードしてから、更新された設定ファイルを使用してレジストリーモードで Quay を再起動します。

10.5. 設定フィールドのミラーリング

| フィールド | 型 | 説明 |

|---|---|---|

| FEATURE_REPO_MIRROR | Boolean |

リポジトリーミラーリングを有効化または無効化します |

| REPO_MIRROR_INTERVAL | Number |

次にリポジトリーミラー候補をチェックするまでの秒数。 |

| REPO_MIRROR_SERVER_HOSTNAME | 文字列 |

|

| REPO_MIRROR_TLS_VERIFY | Boolean |

HTTPS を必要とし、ミラー時に Quay レジストリーの証明書を検証します。 |

| REPO_MIRROR_ROLLBACK | ブール値 |

デフォルト: |

10.6. ミラーリングワーカー

次の手順を使用して、リポジトリーミラーリングワーカーを開始します。

手順

/root/ca.crt証明書を使用して TLS 通信を設定していない場合は、次のコマンドを入力し、repomirrorオプションを指定して、QuayPod を開始します。sudo podman run -d --name mirroring-worker \ -v $QUAY/config:/conf/stack:Z \ {productrepo}/{quayimage}:{productminv} repomirror$ sudo podman run -d --name mirroring-worker \ -v $QUAY/config:/conf/stack:Z \ {productrepo}/{quayimage}:{productminv} repomirrorCopy to Clipboard Copied! Toggle word wrap Toggle overflow /root/ca.crt証明書を使用して TLS 通信を設定している場合は、次のコマンドを入力して、リポジトリーミラーリングワーカーを開始します。sudo podman run -d --name mirroring-worker \ -v $QUAY/config:/conf/stack:Z \ -v /root/ca.crt:/etc/pki/ca-trust/source/anchors/ca.crt:Z \ {productrepo}/{quayimage}:{productminv} repomirror$ sudo podman run -d --name mirroring-worker \ -v $QUAY/config:/conf/stack:Z \ -v /root/ca.crt:/etc/pki/ca-trust/source/anchors/ca.crt:Z \ {productrepo}/{quayimage}:{productminv} repomirrorCopy to Clipboard Copied! Toggle word wrap Toggle overflow

10.7. ミラーリングされたリポジトリーの作成

以下のセクションで説明する手順は、Red Hat Quay クラスターの設定でリポジトリーのミラーリングが有効にされており、リポジトリーミラーリングワーカーをデプロイしていることを前提としています。

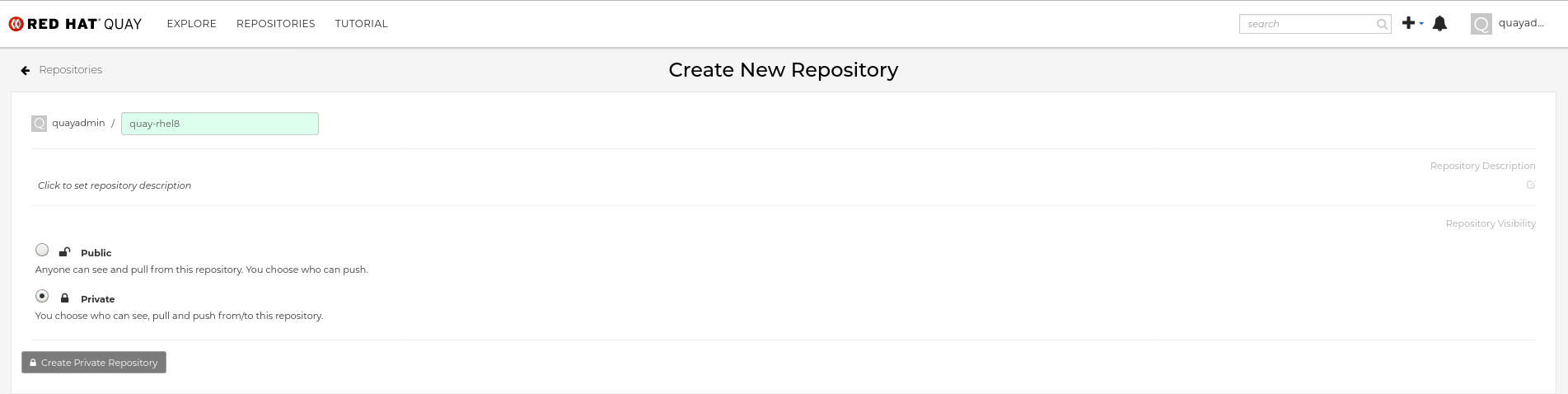

外部コンテナーレジストリーからリポジトリーをミラーリングする場合は、新しいプライベートリポジトリーを作成します。通常、ターゲットリポジトリーと同じ名前が使用されます (例: quay-rhel8)。

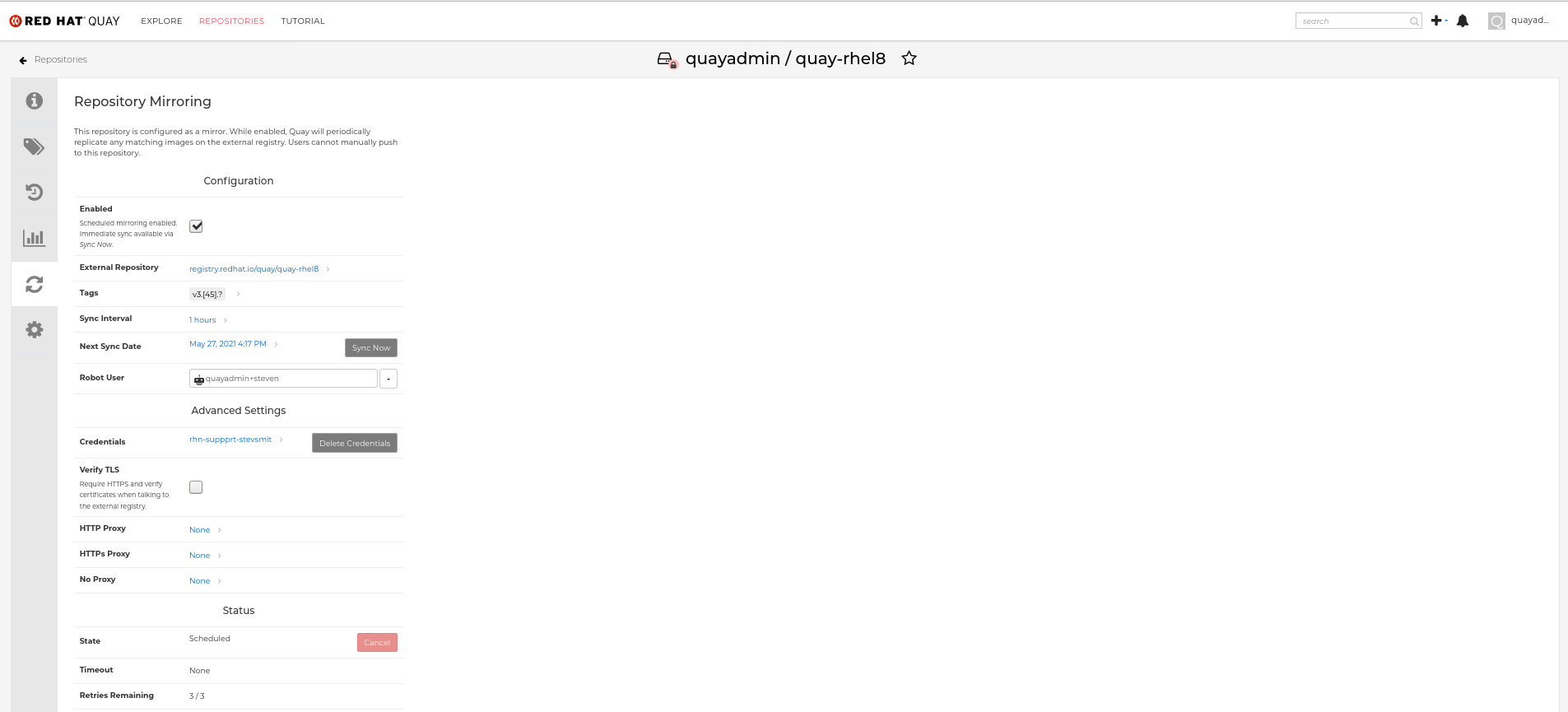

10.7.1. リポジトリーのミラーリングの設定

Settings タブで、Repository State を

Mirrorに設定します。

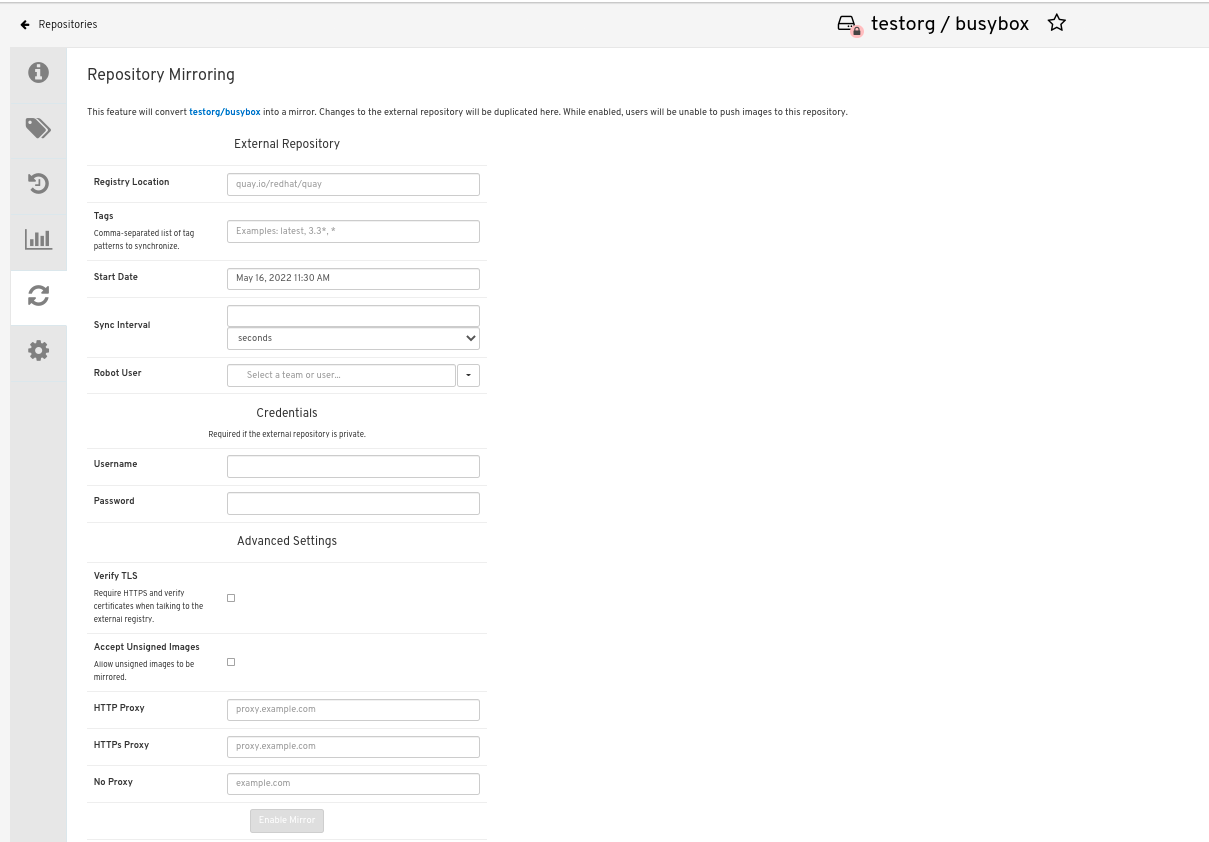

Mirror タブで、タグ、スケジューリング、およびアクセス情報と共に外部レジストリーに接続するための情報を入力します。

必要に応じて、以下のフィールドに詳細を入力します。

-

Registry Location: ミラーリングする外部リポジトリー (例:

registry.redhat.io/quay/quay-rhel8)。 Tags: このフィールドは必須です。個別のタグまたはタグパターンのコンマ区切りの一覧を入力できます。(詳細は、タグパターン のセクションを参照してください。)

注記Quay がリモートリポジトリーのタグの一覧を取得するには、以下のいずれかの要件を満たす必要があります。

- latest タグのあるイメージがリモートリポジトリー OR に存在している必要があります

- パターンの一致のない少なくとも 1 つの明示的なタグが、指定するタグの一覧に存在する必要があります。

- Start Date: ミラーリングが開始する日付。現在の日時がデフォルトで使用されます。

- Sync Interval: デフォルトで 24 時間ごとの同期に設定されます。これは時間または日に基づいて変更できます。

- Robot User: 新しい robot アカウントを作成するか、既存の robot アカウントを選択してミラーリングを実行します。

- Username: ミラーリングするリポジトリーを保持する外部レジストリーにアクセスするためのユーザー名。

- Password: ユーザー名に関連付けられたパスワード。パスワードにはエスケープ文字 (\) を必要とする文字を含めることができないことに注意してください。

-

Registry Location: ミラーリングする外部リポジトリー (例:

10.7.2. 詳細設定

- Advanced Settings セクションで、必要な場合は TLS およびプロキシーを設定します。

- Verify TLS: ターゲットリモートレジストリーと通信する際に、HTTPS が必要であり、証明書を検証する必要がある場合にこのボックスにチェックを付けます。

- HTTP Proxy: リモートサイトへのアクセスに必要な HTTP プロキシーサーバーを特定します (必要な場合)。

- HTTP Proxy: リモートサイトへのアクセスに必要な HTTPS プロキシーサーバーを特定します (必要な場合)。

- No Proxy: プロキシーを必要としない場所の一覧。

10.7.3. 今すぐ同期する

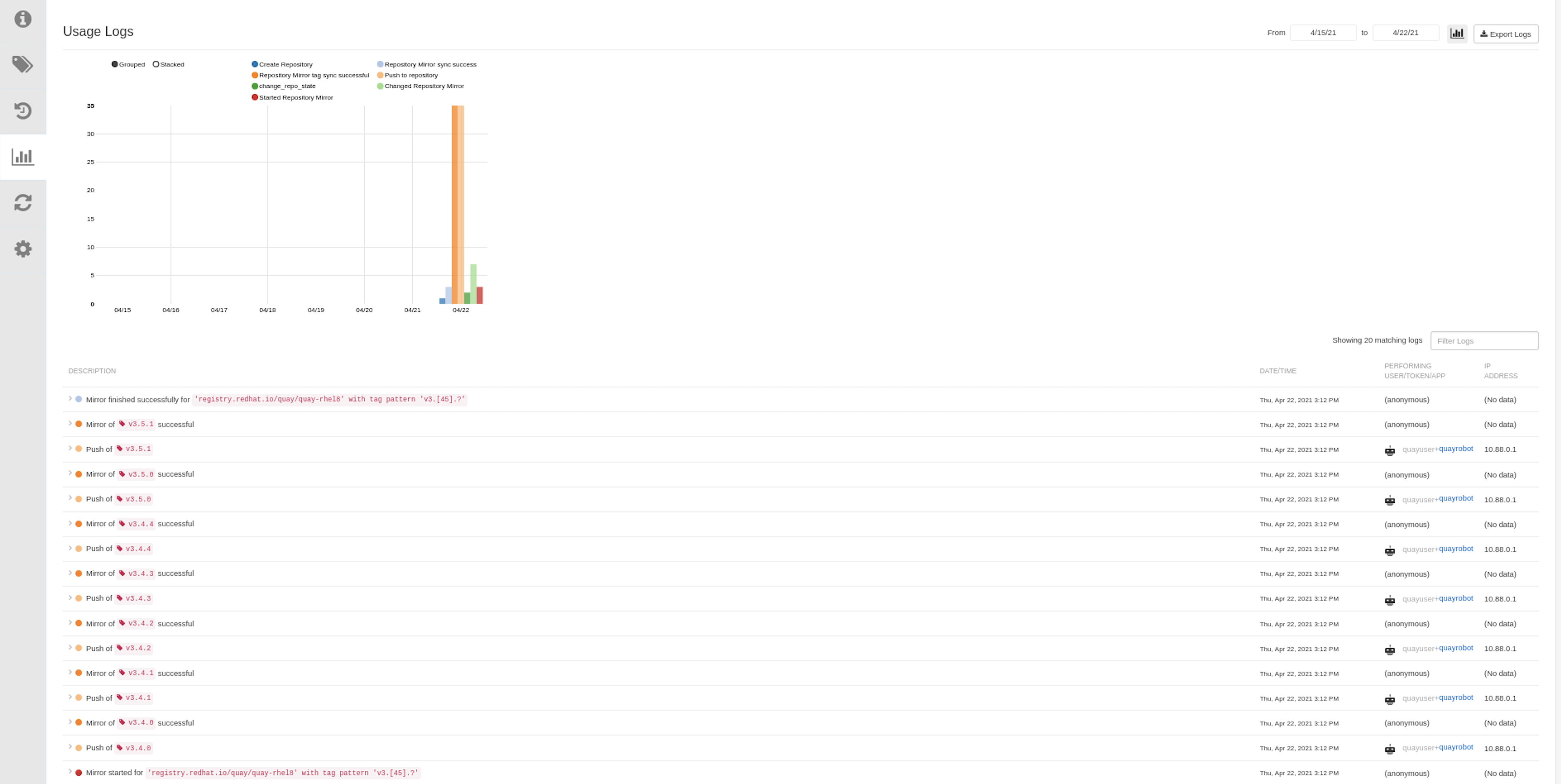

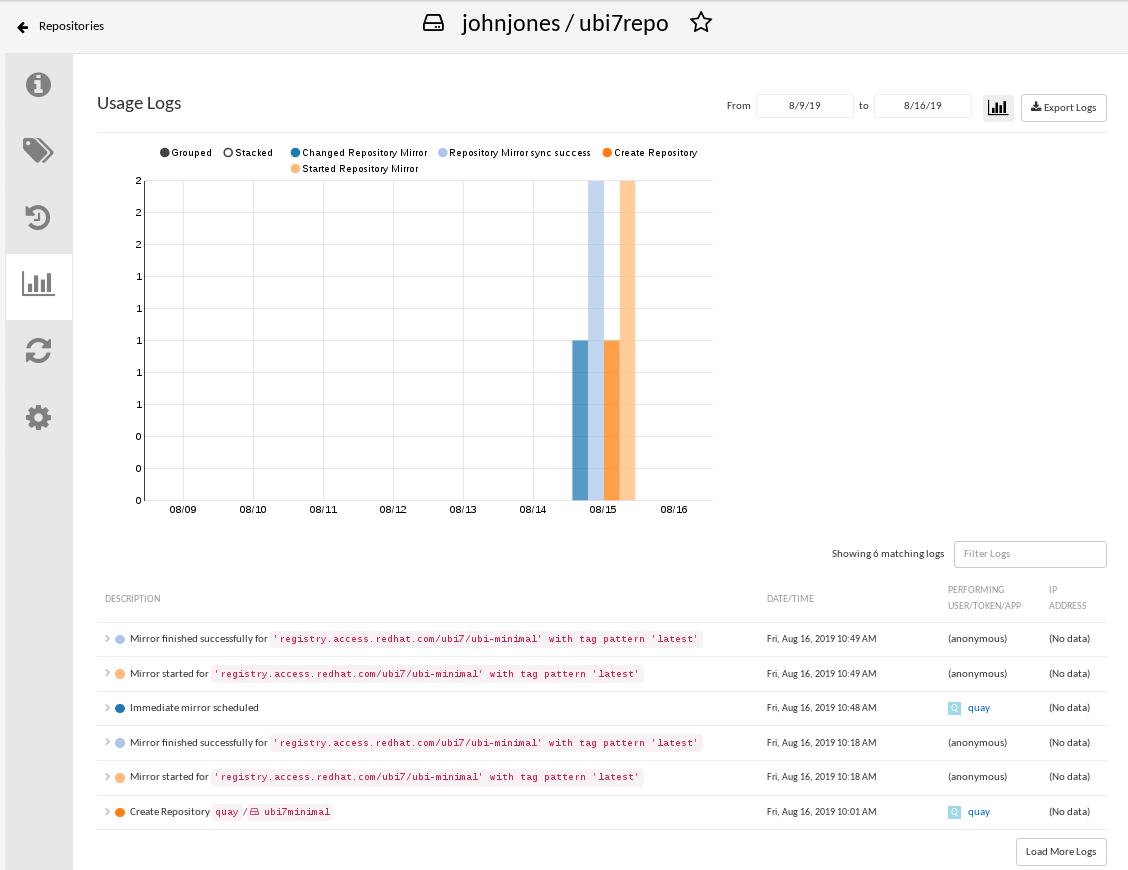

即時にミラーリング操作を実行するには、リポジトリーの Mirroring タブで Sync Now ボタンを押します。ログは、Usage Logs タブで利用できます。

ミラーリングが完了すると、イメージは Tags タブに表示されます。

以下は、完了した Repository Mirroring 画面の例です。

10.8. ミラーリングのイベント通知

リポジトリーミラーリングには、3 つの通知イベントがあります。

- リポジトリーミラーリングの開始

- リポジトリーのミラーリングの成功

- リポジトリーミラーリングの失敗

イベントの設定は、各リポジトリーの Settings タブ内で行うことができ、メール、slack、Quay UI、Web フックなど、既存のすべての通知方法に対応しています。

10.9. タグパターンのミラーリング

上述のように、少なくとも 1 つのタグが明示的に入力されている (つまりタグパターンではない)、または タグ latest がレポートリポジトリーに存在している必要があります。(タグ latest は、タグリストで指定されていないと同期されません。)これは Quay がリモートリポジトリーのタグリストを取得し、ミラーリングするために指定したリストと比較するために必要です。

10.9.1. パターン構文

| パターン | 説明 |

| * | すべての文字に一致します。 |

| ? | 任意の単一文字に一致します。 |

| [seq] | seq の任意の文字と一致します。 |

| [!seq] | seq にない文字と一致します。 |

10.9.2. タグのパターン例

| パターン例 | マッチの例 |

| v3* | v32、v3.1、v3.2、v3.2-4beta、v3.3 |

| v3.* | v3.1、v3.2、v3.2-4beta |

| v3.? | v3.1、v3.2、v3.3 |

| v3.[12] | v3.1、v3.2 |

| v3.[12]* | v3.1、v3.2、v3.2-4beta |

| v3.[!1]* | v3.2、v3.2-4beta、v3.3 |

10.10. ミラーリングされたリポジトリーの使用

ミラーリングされたリポジトリーを作成した後、そのリポジトリーを操作する方法はいくつかあります。Repositories ページからミラーリングされたリポジトリーを選択し、以下のいずれかを行います。

- リポジトリーの有効化/無効化: 左列の Mirroring ボタンを選択してから Enabled チェックボックスを切り替え、一時的にリポジトリーを有効または無効にします。

ミラーログの確認: ミラーリングされたリポジトリーが正常に動作していることを確認するために、ミラーログを確認することができます。そのためには、左カラムの Usage Logs ボタンを選択します。以下に例を示します。

- 今すぐミラーを同期: リポジトリー内のイメージをすぐに同期するには、Sync Now ボタンを選択します。

- クレデンシャルの変更: ユーザー名とパスワードを変更するには、Credentials の行から DELETE を選択します。その後、なしを選択し、プロンプトが表示されたら、外部レジストリーにログインするために必要なユーザー名とパスワードを追加します。

- ミラーリングのキャンセル: ミラーリングを中止するには、CANCEL ボタンを選択します。これにより、現在のイメージはそのまま利用できますが、新しいイメージは同期されなくなります。

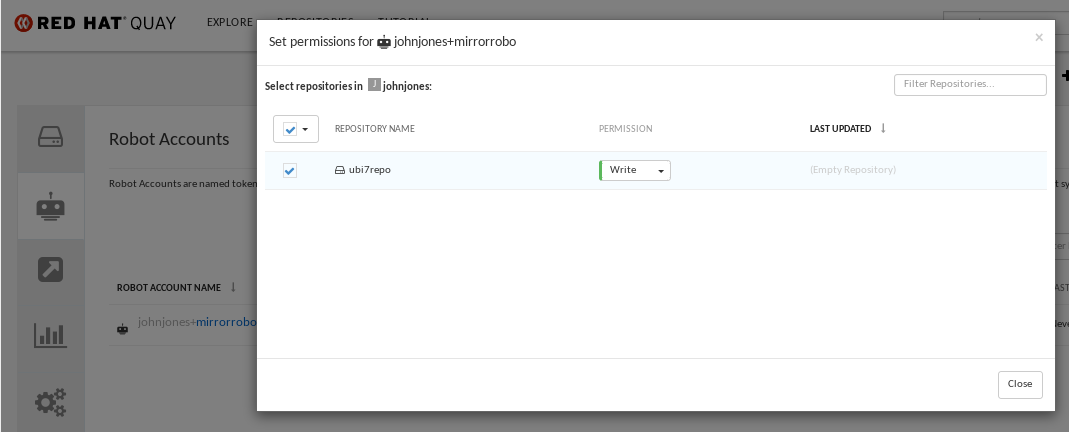

ロボットのパーミッション設定: Red Hat Quay のロボットアカウントは、外部のリポジトリーにアクセスするための認証情報を保持する名前付きのトークンです。ロボットに認証情報を割り当てることで、そのロボットは、同じ外部レジストリーにアクセスする必要のある複数のミラーリングされたリポジトリーで使用することができます。

既存のロボットをリポジトリーに割り当てるには、Account Settings を開き、左カラムの Robot Accounts アイコンを選択します。ロボットアカウントの場合は、REPOSITORIES 欄のリンクを選択します。ポップアップウィンドウから、以下のことができます。

- そのロボットにどのリポジトリーが割り当てられているかを確認します。

-

この図に示されている PERMISSION フィールドから対象のロボットに読み取り、書き込み、または管理者権限を割り当てます。

ロボット認証情報の変更: ロボットは、Kubernetes の秘密、Docker のログイン情報、Mesos のバンドルなどの認証情報を保持することができます。ロボットの認証情報を変更するには、Robot Accounts ウィンドウのロボットのアカウント行にある Options ギアを選択し、View Credentials を選択します。ロボットがアクセスする必要のある外部リポジトリーの適切な認証情報を追加します。

- 一般設定の確認と変更: ミラーリングされたリポジトリーのページの左カラムから設定ボタン (歯車のアイコン) を選択します。表示されるページでは、ミラーリングされたリポジトリーに関連する設定を変更できます。特に、ユーザーやロボットのパーミッションを変更して、どのユーザーやロボットがレポジトリーを読み書きできるかを正確に指定することができます。

10.11. リポジトリーのミラーリングの推奨事項

リポジトリーミラーリングのベストプラクティスには、以下が含まれます。

- リポジトリーミラーリング Pod は任意のノードで実行できます。つまり、Red Hat Quay がすでに実行されているノードでミラーリングを実行することもできます。

- リポジトリーのミラーリングは、データベースでスケジュールされ、一括して実行されます。その結果、ワーカーが増えれば、より多くのバッチが処理されるため、ミラーリングが速くなる可能性があります。

ミラーリング Pod の最適な数は、以下の要素により変わります。

- ミラーリングされるリポジトリーの合計数

- リポジトリー内のイメージやタグの数と変更の頻度

- 並列バッチ

- すべてのミラーリングされたリポジトリーが同時に起動しないように、ミラーリングのスケジュールをバランスよく設定する必要があります。

- ユーザー数が約 1000 人、リポジトリー数が約 1000 個、ミラーリングされたリポジトリー数が約 100 個の中規模のデプロイメントでは、3 ~ 5 個のミラーリング Pod を使用し、必要に応じて 10 Pod にスケールアップすることを想定しています。

第11章 Red Hat Quay の LDAP 認証設定

LDAP (Lightweight Directory Access Protocol) は、IP ネットワークで分散ディレクトリー情報サービスにアクセスし、これを維持するために使用するオープンな、ベンダーに依存しない業界標準のアプリケーションプロトコルです。Red Hat Quay は ID プロバイダーとして LDAP の使用をサポートしています。

11.1. LDAP を有効にする前の考慮事項

11.1.1. 既存の Quay デプロイメント

ユーザーがすでに設定されている既存の Quay デプロイメントで LDAP を有効にすると、ユーザー名との競合が発生する可能性があります。LDAP を有効にする前に、Quay で特定のユーザー alice を手動作成したシナリオを考慮してください。ユーザー名 alice が LDAP ディレクトリーにも存在する場合に、alice が LDAP を使用して初回ログインしたときに、Quay は新規ユーザー alice-1 を作成し、LDAP 認証情報をこのアカウントにマップします。これは、整合性の理由から望ましくない可能性があり、LDAP を有効にする前に、Quay からローカルのアカウント名で競合する可能性のある名前を削除することを推奨します。

11.1.2. 手動ユーザーの作成と LDAP 認証

Quay が LDAP 用に設定されていて、設定オプション FEATURE_USER_CREATION が true に設定されている場合は、LDAP 認証ユーザーが最初のログイン時に Quay のデータベースに自動的に作成されます。このオプションを false に設定すると、LDAP ユーザーの自動ユーザー作成に失敗し、ユーザーはログインできません。このシナリオでは、スーパーユーザーが最初に必要なユーザーアカウントを作成する必要があります。一方、FEATURE_USER_CREATION が true に設定されている場合は、LDAP に同等のユーザーがある場合でも、ユーザーは Quay ログイン画面からもアカウントを作成できます。

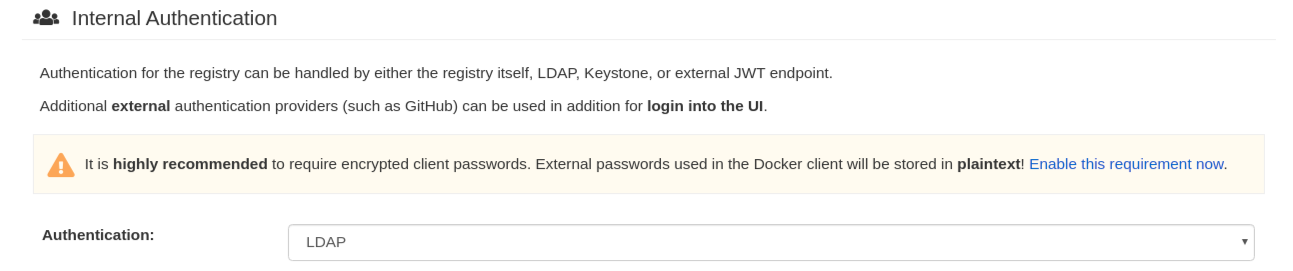

11.2. LDAP の設定

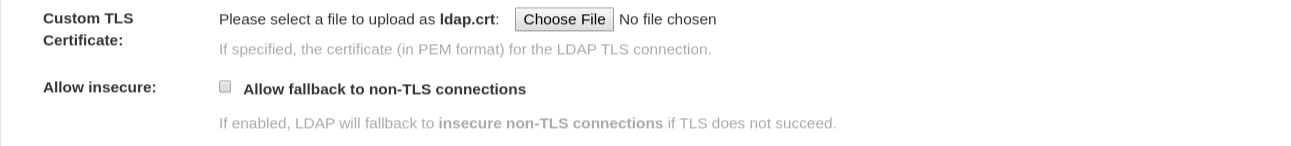

設定ツールで認証の項目を探し、ドロップダウンメニューから LDAP を選択します。必要に応じて LDAP 設定項目を更新してください。

- 以下は、config.yaml ファイルの結果としてのエントリーの例です。

AUTHENTICATION_TYPE: LDAP

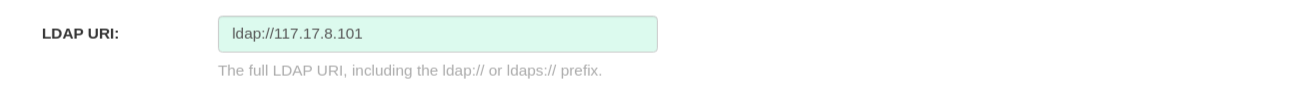

AUTHENTICATION_TYPE: LDAP11.2.1. 完全な LDAP URI

- ldap:// または ldaps:// の接頭辞を含む、完全な LDAP URI。

- ldaps:// で始まる URI は、提供された SSL 証明書を使用して TLS の設定を行います。

- 以下は、config.yaml ファイルの結果としてのエントリーの例です。

LDAP_URI: ldaps://ldap.example.org

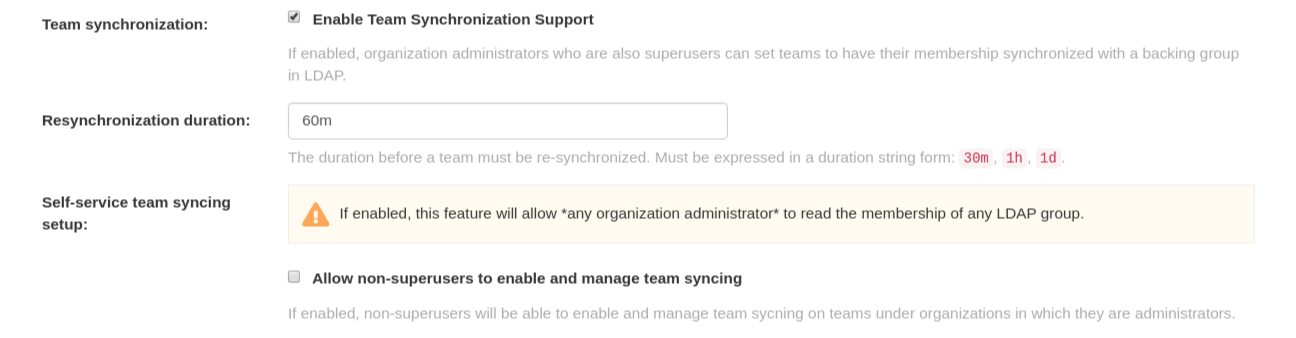

LDAP_URI: ldaps://ldap.example.org11.2.2. チームシンクロナイゼーション

- この機能を有効にすると、スーパーユーザーである組織管理者は、チームのメンバーシップを LDAP の下位グループと同期させるように設定できます。

- 再同期期間とは、チームを再同期させる必要がある期間のことです。継続時間を文字列形式で表現する必要があります (30m、1h、1d)。

- オプションとして、管理者である組織の下で、スーパーユーザー以外の人がチームの同期を有効にして管理できるようにします。

- 以下は、config.yaml ファイルの結果としてのエントリーの例です。

FEATURE_TEAM_SYNCING: true TEAM_RESYNC_STALE_TIME: 60m FEATURE_NONSUPERUSER_TEAM_SYNCING_SETUP: true

FEATURE_TEAM_SYNCING: true

TEAM_RESYNC_STALE_TIME: 60m

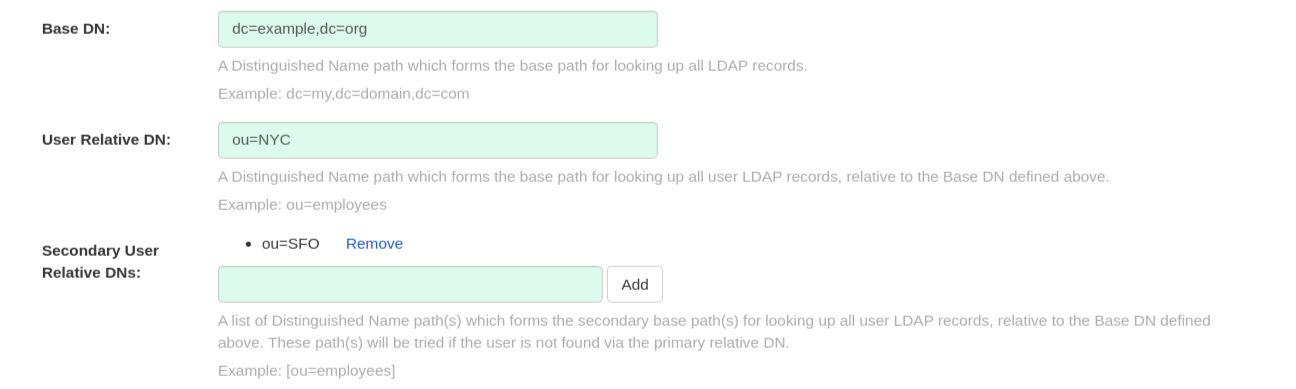

FEATURE_NONSUPERUSER_TEAM_SYNCING_SETUP: true11.2.3. ベースおよび相対的な区別された名前

- すべての LDAP レコードを検索するための基本パスとなる識別名のパス。たとえば、dc=my,dc=domain,dc=com です。

- すべてのユーザーの LDAP レコードを検索するための第二のベースパスとなる、上記で定義したベース DN に相対する識別名パスのリスト (オプション)。これらのパスは、プライマリーの相対的な DN でユーザーを見つけられなかった場合に試行されます。

- User Relative DN は BaseDN からの相対的なものです。たとえば、ou=NYC,dc=example,dc=org ではなく ou=NYC です。

- ユーザーオブジェクトが配置されている Organizational Unit が複数ある場合は、Secondary User Relative DN を複数入力することができます。複数の RDN を追加するには、Organizational Unit を入力して Add ボタンをクリックします。たとえば、ou=Users,ou=NYC および ou=Users,ou=SFO です。

- User Relative DN はサブツリーのスコープで検索します。たとえば、組織に Users OU 下に組織単位 NYC および SFO がある場合 (ou=SFO,ou=Users および ou=NYC,ou=Users)、Red Hat Quay は、ユーザー相対 DN がユーザーに設定されている場合 (ou=Users)、 NYC および SFO 組織単位のどちらのユーザーも認証できます。

- 以下は、config.yaml ファイルの結果としてのエントリーの例です。

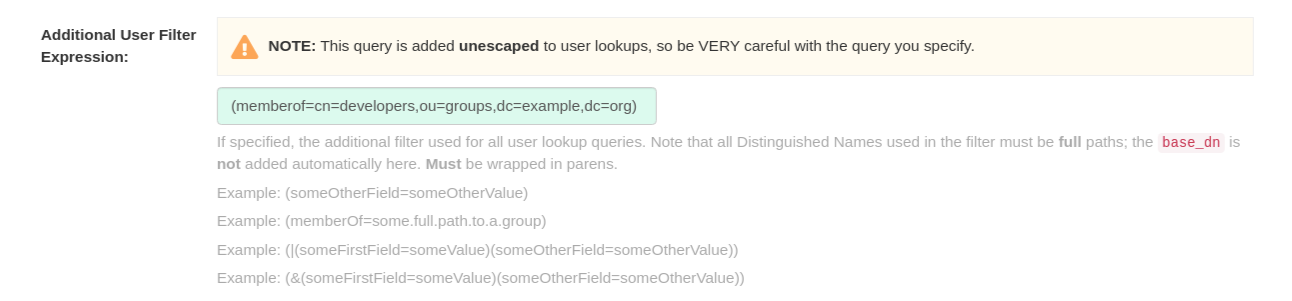

11.2.4. ユーザーフィルターの追加

- 指定された場合は、すべてのユーザー検索クエリーで使用される追加フィルターとなります。なお、フィルターで使用する識別名はすべて 完全 パスでなければならず、ベース DN はここでは自動的に追加されません。括弧でくくる必要があります。たとえば、(&(someFirstField=someValue)(someOtherField=someOtherValue)) です。

- 以下は、config.yaml ファイルの結果としてのエントリーの例です。

LDAP_USER_FILTER: (memberof=cn=developers,ou=groups,dc=example,dc=com)

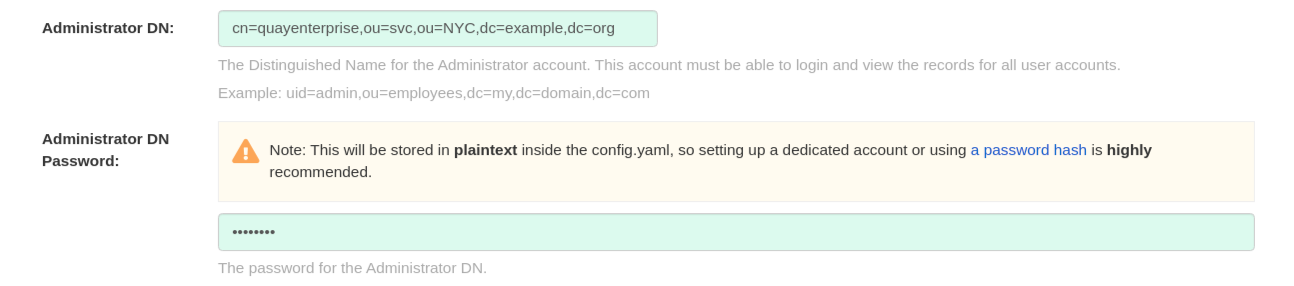

LDAP_USER_FILTER: (memberof=cn=developers,ou=groups,dc=example,dc=com)11.2.5. 管理者 DN

- 管理者アカウントの Distinguished Name (識別名) と Password (パスワード)。このアカウントは、ログインしてすべてのユーザーアカウントの記録を閲覧できる必要があります。たとえば、uid=admin,ou=employees,dc=my,dc=domain,dc=com です。

- パスワードは config.yaml 内に 平文 で保存されるため、専用のアカウントを設定するか、パスワードハッシュを使用することを強くお勧めします。

- 以下は、config.yaml ファイルの結果としてのエントリーの例です。

LDAP_ADMIN_DN: cn=admin,dc=example,dc=com LDAP_ADMIN_PASSWD: changeme

LDAP_ADMIN_DN: cn=admin,dc=example,dc=com

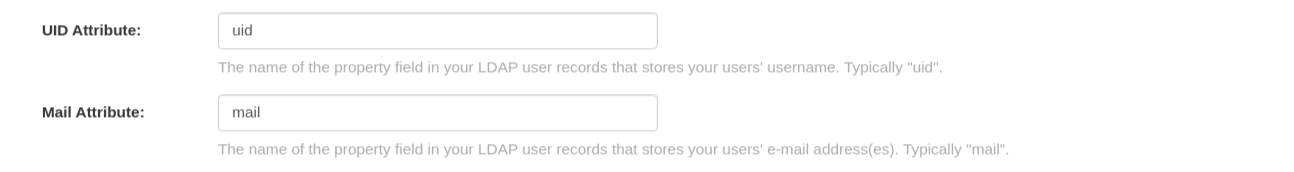

LDAP_ADMIN_PASSWD: changeme11.2.6. UID およびメール属性

- UID 属性は、ユーザー名 として使用する LDAP ユーザーレコードのプロパティーフィールドの名前です。一般的には、uid です。

- Mail 属性は、LDAP ユーザーレコードのプロパティーフィールドの名前で、ユーザーの電子メールアドレスが格納されています。一般的には mail です。

- いずれもログイン時に使用することができます。

- ログインしたユーザー名が User Relative DN に存在している必要があります。

- sAMAccountName は、Microsoft Active Directory の設定に対する UID 属性です。

- 以下は、config.yaml ファイルの結果としてのエントリーの例です。

LDAP_UID_ATTR: uid LDAP_EMAIL_ATTR: mail

LDAP_UID_ATTR: uid

LDAP_EMAIL_ATTR: mail11.2.7. 検証

設定が完了したら、Save Configuration Changes ボタンをクリックして設定を有効にします。

すべての検証が成功しないと先に進めません。また、編集を続けるボタンを選択して追加の設定を行うこともできます。

11.3. 共通の課題

無効な認証情報

Administrator DN または Administrator DN Password の値が正しくない

スーパーユーザー %USERNAME% の検証に失敗しました。ユーザー名が見つかりません。ユーザーがリモート認証システムに存在しないか、LDAP 認証の設定が間違っています。

Red Hat Quay は Administrator DN フィールドで指定された Username/Password で LDAP サーバーに接続できますが、User Relative DN Path の UID Attribute または Mail Attribute フィールドで現在ログインしているユーザーを見つけることができません。現在ログインしているユーザーが User Relative DN Path に存在しないか、管理者 DN ユーザーにこの LDAP パスの検索/読み取り権限がありません。

11.4. LDAP ユーザーをスーパーユーザーとして設定

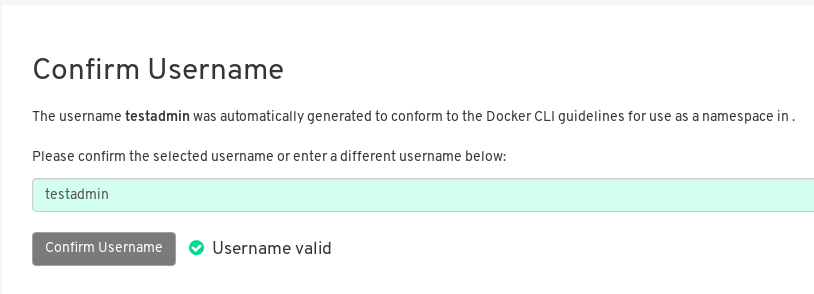

LDAP が設定されると、有効な LDAP ユーザー名とパスワードで Red Hat Quay インスタンスにログインできるようになります。次の図のように、Red Hat Quay のユーザー名を確認するプロンプトが表示されます。

LDAP ユーザーにスーパーユーザー権限を付与するには、config.yaml ファイルのユーザー名を変更します。以下に例を示します。

SUPER_USERS: - testadmin

SUPER_USERS:

- testadmin

更新された config.yaml ファイルを使用して Red Hat Quay コンテナーを再起動します。次回のログイン時には、そのユーザーはスーパーユーザーの権限を持つことになります。

第12章 Red Hat Quay の下での Prometheus および Grafana のメトリクス

Red Hat Quay は、各インスタンスに Prometheus と Grafana に対応したエンドポイントをエクスポートし、簡単にモニタリングとアラートを行うことができます。

12.1. Prometheus エンドポイントの公開

12.1.1. スタンドアロン Red Hat Quay

podman run を使用して Quay コンテナーを起動する場合は、メトリクスポート 9091 を公開します。

sudo podman run -d --rm -p 80:8080 -p 443:8443 -p 9091:9091\ --name=quay \ -v $QUAY/config:/conf/stack:Z \ -v $QUAY/storage:/datastorage:Z \ registry.redhat.io/quay/quay-rhel8:v3.7.13

$ sudo podman run -d --rm -p 80:8080 -p 443:8443 -p 9091:9091\

--name=quay \

-v $QUAY/config:/conf/stack:Z \

-v $QUAY/storage:/datastorage:Z \

registry.redhat.io/quay/quay-rhel8:v3.7.13これでメトリクスが利用可能になります。

curl quay.example.com:9091/metrics

$ curl quay.example.com:9091/metricsQuay のリポジトリーカウントを監視するための Prometheus および Grafana の設定については、Monitoring Quay with Prometheus and Grafana を参照してください。

12.1.2. Red Hat Quay Operator

quay-metrics サービスのクラスター IP を判別します。

クラスターに接続し、quay-metrics サービスのクラスター IP およびポートを使用してメトリクスにアクセスします。

12.1.3. Prometheus がメトリクスを消費するための設定

Prometheus は、クラスター内で実行されているすべての Red Hat Quay インスタンスにアクセスする方法が必要です。典型的なセットアップでは、すべての Red Hat Quay インスタンスを単一の名前付き DNS エントリーにリストアップし、それを Prometheus に渡すことで行われます。

12.1.4. Kubernetes での DNS 設定

シンプルな Kubernetes service を設定して、Prometheus の DNS エントリーを提供することができます。

12.1.5. 手動クラスターの DNS 設定

SkyDNS は、Kubernetes を使用していない場合に、この DNS レコードを管理するためのシンプルなソリューションです。SkyDNS は、etcd クラスター上で動作させることができます。クラスター内の各 Red Hat Quay インスタンスのエントリーを etcd ストアに追加、削除することができます。SkyDNS はそこから定期的に読み込んで、それに応じて DNS レコードの Quay インスタンスのリストを更新します。

12.2. メトリクスの概要

Red Hat Quay には、一般的なレジストリーの使用、アップロード、ダウンロード、ガベージコレクション、および認証についてのメトリクスなど、レジストリーの監視に役立つメトリクスが同梱されています。

12.2.1. 一般レジストリーの統計

一般的なレジストリー統計で、どの程度レジストリーが拡大しているかが分かります。

| メトリクス名 | 説明 |

|---|---|

| quay_user_rows | データベースのユーザー数 |

| quay_robot_rows | データベースのロボットアカウントの数 |

| quay_org_rows | データベースの組織数 |

| quay_repository_rows | データベースのリポジトリー数 |

| quay_security_scanning_unscanned_images_remaining_total | 最新のセキュリティースキャナーによってスキャンされないイメージの数 |

メトリクスの出力サンプル

12.2.2. キューアイテム

キューアイテム メトリクスでは、作業管理用に Quay が使用する複数のキューに関する情報が分かります。

| メトリクス名 | 説明 |

|---|---|

| quay_queue_items_available | 特定のキュー内のアイテム数 |

| quay_queue_items_locked | 実行中のアイテム数 |

| quay_queue_items_available_unlocked | 処理を待機しているアイテム数 |

メトリックラベル

QUEUE_NAME: キューの名前。以下のいずれかになります。

- exportactionlogs: アクションログをエクスポートするためのキューに追加されている要求。これらのログは処理され、ストレージに配置されます。その後、リンクがメールを介して要求元に送信されます。

- namespacegc: キューに追加されてガベージコレクションされる namespace

- notification: リポジトリー通知が送信されるキュー

- repositorygc: ガベージコレクションを行うレポジトリーでキューに追加されているもの

- secscanv4: Clair V4 に固有の通知キュー

- dockerfilebuild: Quay docker ビルドのキュー

- imagestoragereplication: 複数のストレージで複製されるようにキューに追加されている Blob

- chunk_cleanup: 削除する必要があり、キューに追加されている Blog セグメント。これは、一部のストレージ実装 (Swift など) でのみ使用されます。

たとえば、キューラベルの repositorygc には、リポジトリーのガべージコレクションワーカーによって削除対象としてマークされたリポジトリーが含まれます。repositorygc の queue_name ラベル付きのメトリクスの場合は、以下のようになります。

- quay_queue_items_locked は、現在削除されているリポジトリーの数です。

- quay_queue_items_available_unlocked は、ワーカーが処理するのを待機するリポジトリーの数です。

メトリクスの出力サンプル

12.2.3. ガベージコレクションメトリクス

これらのメトリクスは、ガベージコレクション (gc) から削除されたリソースの数を示します。ここでは、gc ワーカーが実行した回数と、削除された namespace、リポジトリー、および Blob の数が示されます。

| メトリクス名 | 説明 |

|---|---|

| quay_gc_iterations_total | GCWorker による反復の数 |

| quay_gc_namespaces_purged_total | NamespaceGCWorker によってパージされる namespace 数 |

| quay_gc_repos_purged_total | RepositoryGCWorker または NamespaceGCWorker がパージするリポジトリーの数 |

| quay_gc_storage_blobs_deleted_total | 削除されたストレージ Blob の数 |

メトリクスの出力サンプル

12.2.3.1. マルチパートアップロードメトリクス

マルチパートアップロードメトリクスは、ストレージへの Blob アップロードの数 (S3、Raddos、GoogleCloudStorage、RHOCS) を表示します。これらは、Quay が Blob をストレージに正しくアップロードできない場合の問題を特定するのに役立ちます。

| メトリクス名 | 説明 |

|---|---|

| quay_multipart_uploads_started_total | 起動した Quay ストレージへのマルチパートアップロードの数 |

| quay_multipart_uploads_completed_total | 完了した Quay ストレージへのマルチパートアップロードの数 |

メトリクスの出力サンプル

12.2.4. イメージのプッシュ/プルのメトリクス

イメージのプッシュおよびプルに関連する数多くのメトリクスを利用できます。

12.2.4.1. イメージプルの合計

| メトリクス名 | 説明 |

|---|---|

| quay_registry_image_pulls_total | レジストリーからダウンロードされたイメージの数 |

メトリックラベル

- プロトコル: 使用するレジストリープロトコル (常に v2 に指定する)

- ref: -tag マニフェストのプルに使用する ref

- status: 要求の http 戻りコード

12.2.4.2. プルしたイメージ (バイト)

| メトリクス名 | 説明 |

|---|---|

| quay_registry_image_pulled_estimated_bytes_total | レジストリーからダウンロードされたバイト数 |

メトリックラベル

- プロトコル: 使用するレジストリープロトコル (常に v2 に指定する)

12.2.4.3. イメージのプッシュ合計

| メトリクス名 | 説明 |

|---|---|

| quay_registry_image_pushes_total | レジストリーからアップロードされたイメージの数 |

メトリックラベル

- プロトコル: 使用するレジストリープロトコル (常に v2 に指定する)

- pstatus: 要求の http 戻りコード

- pmedia_type: アップロードしたマニフェストタイプ

12.2.4.4. プッシュされたイメージバイト

| メトリクス名 | 説明 |

|---|---|

| quay_registry_image_pushed_bytes_total | レジストリーにアップロードされたバイト数 |

メトリクスの出力サンプル

# HELP quay_registry_image_pushed_bytes_total number of bytes pushed to the registry

# TYPE quay_registry_image_pushed_bytes_total counter

quay_registry_image_pushed_bytes_total{host="example-registry-quay-app-6df87f7b66-9tfn6",instance="",job="quay",pid="221",process_name="registry:application"} 0

...

# HELP quay_registry_image_pushed_bytes_total number of bytes pushed to the registry

# TYPE quay_registry_image_pushed_bytes_total counter

quay_registry_image_pushed_bytes_total{host="example-registry-quay-app-6df87f7b66-9tfn6",instance="",job="quay",pid="221",process_name="registry:application"} 0

...12.2.5. 認証メトリクス

認証メトリクスでは、タイプ別にラベルが付けられた認証要求の数と、成功したかどうかが分かります。たとえば、このメトリックを使用して、失敗した Basic 認証要求を監視できます。

| メトリクス名 | 説明 |

|---|---|

| quay_authentication_attempts_total | レジストリーおよび API 全体で認証を試行する回数 |

メトリックラベル

auth_kind: 使用される認証のタイプ。以下が含まれます。

- basic

- oauth

- credentials

- 成功: true または false

メトリクスの出力サンプル

第13章 Red Hat Quay のクォータ管理および施行

Red Hat Quay 3.7 では、ユーザーは、設定されたストレージクォータ制限を確立することにより、ストレージ消費を報告し、レジストリーの増加を抑えることができます。オンプレミス Quay ユーザーには、環境の容量制限を管理するために以下の機能が追加されました。

- クォータレポート: この機能を使用すると、スーパーユーザーはすべての組織のストレージ消費量を追跡できます。さらに、ユーザーは割り当てられた組織のストレージ消費量を追跡できます。

- クォータ管理: この機能を使用すると、スーパーユーザーは Red Hat Quay ユーザーのソフトチェックとハードチェックを定義できます。ソフトチェックは、組織のストレージ消費量が設定されたしきい値に達しているかどうかをユーザーに通知します。ハードチェックは、ストレージ消費量が設定された制限に達したときにユーザーがレジストリーにプッシュするのを防ぎます。

これらの機能を組み合わせることで、Quay レジストリーのサービス所有者は、サービスレベル契約を定義し、健全なリソース予算をサポートできます。

13.1. クォータ管理設定

クォータ管理は FEATURE_QUOTA_MANAGEMENT プロパティーでサポートされるようになり、デフォルトでオフになっています。クォータ管理を有効にするには、config.yaml の機能フラグを true に設定します。

FEATURE_QUOTA_MANAGEMENT: true

FEATURE_QUOTA_MANAGEMENT: trueRed Hat Quay 3.7 では、クォータを作成、更新、削除するにはスーパーユーザー権限が必要です。クォータはユーザーと組織に設定できますが、Red Hat Quay UI を使用して ユーザー クォータを再設定することはできず、代わりに API を使用する必要があります。

13.1.1. デフォルトのクォータ

すべての組織およびユーザーに適用されるシステム全体のデフォルトのストレージクォータを指定するには、DEFAULT_SYSTEM_REJECT_QUOTA_BYTES 設定フラグを使用します。

| フィールド | 型 | 説明 |

|---|---|---|

| DEFAULT_SYSTEM_REJECT_QUOTA_BYTES | 文字列 |

すべての組織およびユーザーに適用するクォータサイズ |

組織またはユーザーに特定のクォータを設定してから、そのクォータを削除すると、システム全体のデフォルトのクォータが設定されている場合に適用されます。同様に、組織またはユーザーに特定のクォータを設定してから、システム全体のデフォルトクォータを変更した場合、更新されたシステム全体のデフォルトは特定の設定を上書きします。

13.2. クォータ管理アーキテクチャー

RepositorySize データベーステーブルは、組織内の Red Hat Quay リポジトリーのストレージ消費量をバイト単位で保持します。組織のすべてのリポジトリーサイズの合計は、Red Hat Quay 組織の現在のストレージサイズを定義します。イメージプッシュが初期化されると、ユーザーの組織ストレージが検証され、設定されたクォータ制限を超えているかどうかがチェックされます。イメージプッシュが定義されたクォータ制限を超えると、ソフトチェックまたはハードチェックが発生します。

- ソフトチェックの場合は、ユーザーに通知されます。

- ハードチェックの場合は、プッシュが停止します。

ストレージ消費量が設定済みのクォータ制限内にある場合は、プッシュを続行できます。

イメージマニフェストの削除も同様のフローに従い、関連するイメージタグとマニフェストの間のリンクが削除されます。さらに、イメージマニフェストが削除された後、リポジトリーサイズが再計算され、RepositorySize テーブルで更新されます。

13.3. Red Hat Quay UI でクォータの確立

次の手順では、ストレージ消費量をレポートし、ストレージクォータ制限を設定する方法を説明します。

前提条件

- Red Hat Quay レジストリー

- スーパーユーザーアカウント

- クォータ制限の要求を満たすのに十分なストレージ

手順

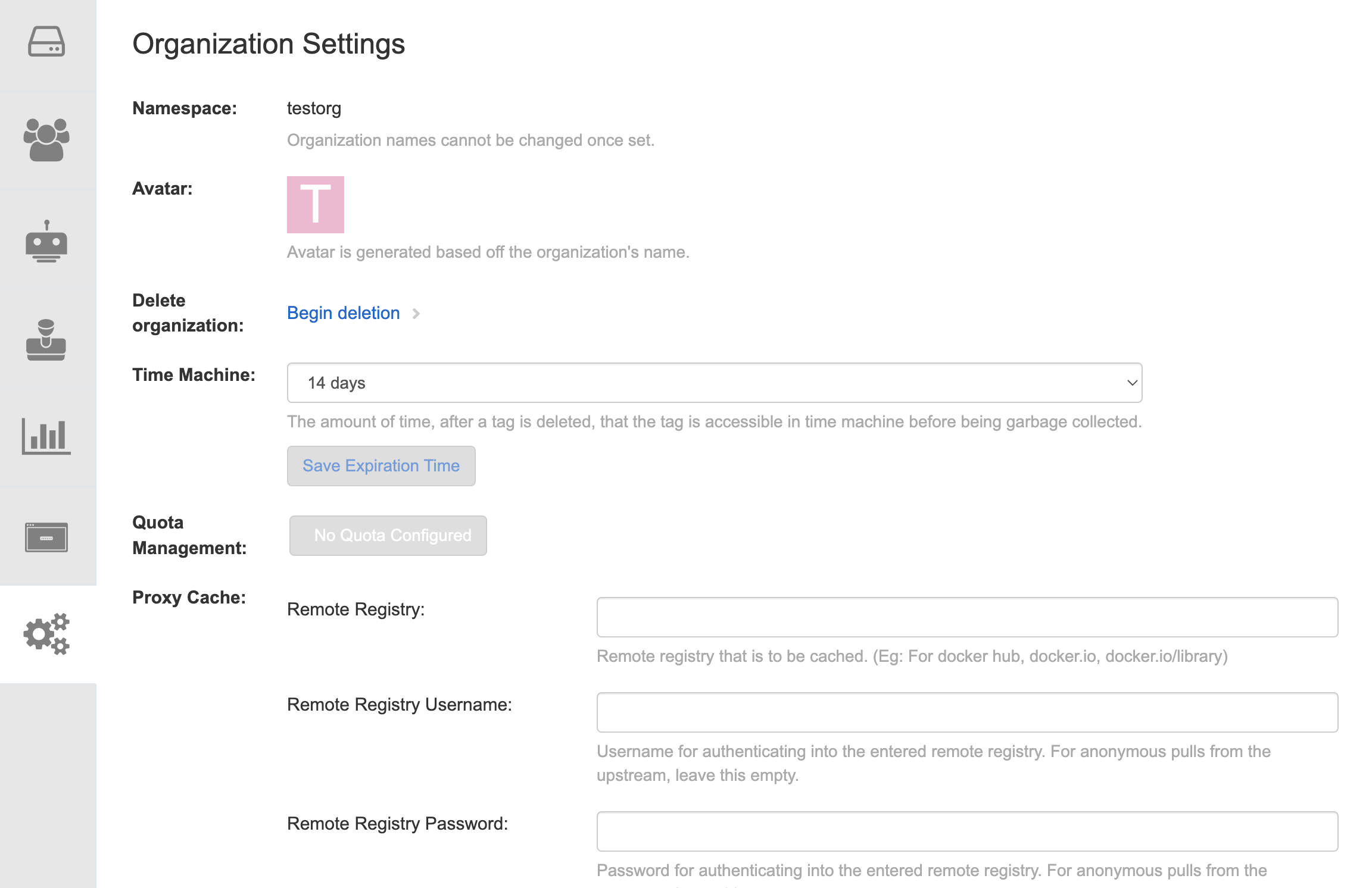

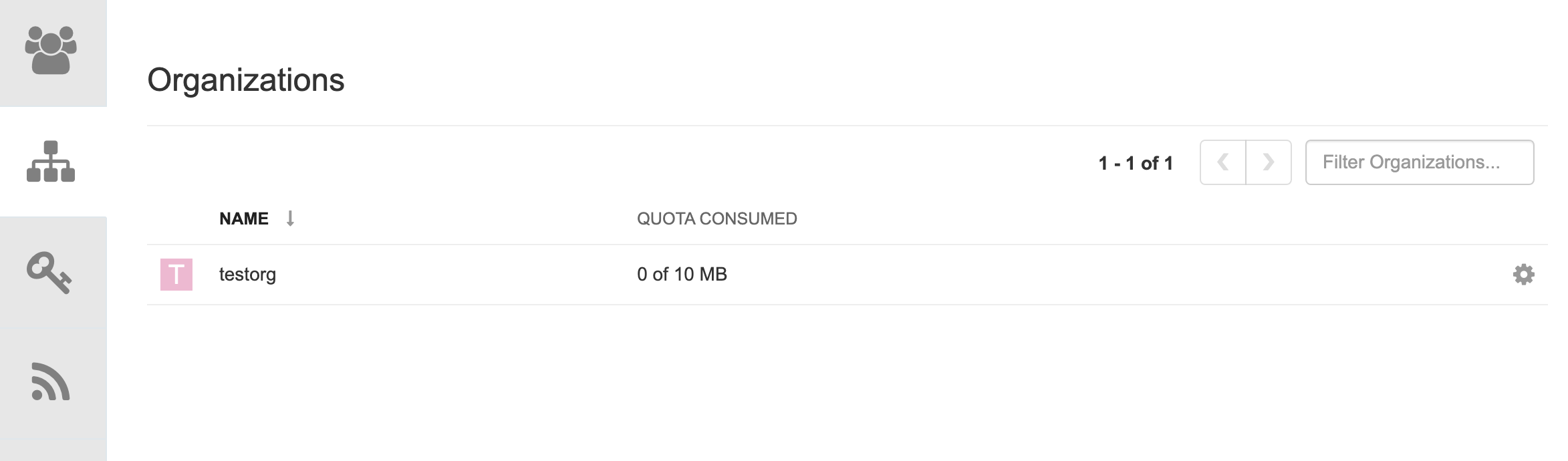

新しい組織を作成するか、既存の組織を選択します。Organization Settings タブに表示されているように、最初はクォータが設定されていません。

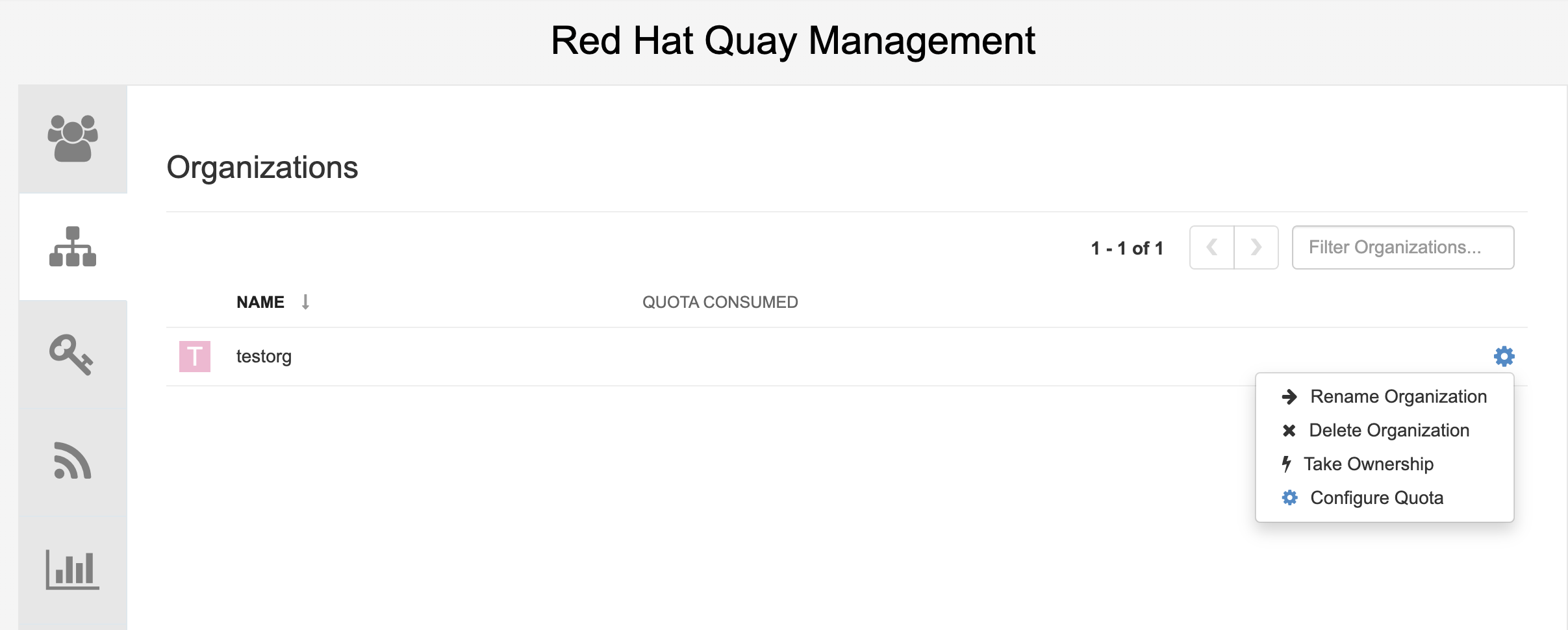

スーパーユーザーとしてレジストリーにログインし、Super User Admin Panel の Manage Organizations タブに移動します。ストレージクォータ制限を作成する組織の Options アイコンをクリックします。

Configure Quota をクリックして、初期クォータ (たとえば 10 MB) を入力します。次に、Apply をクリックしてから Close をクリックします。

スーパーユーザーパネルの Manage Organizations タブで、消費されたクォータが 10MB のうち 0 を示していることを確認します。

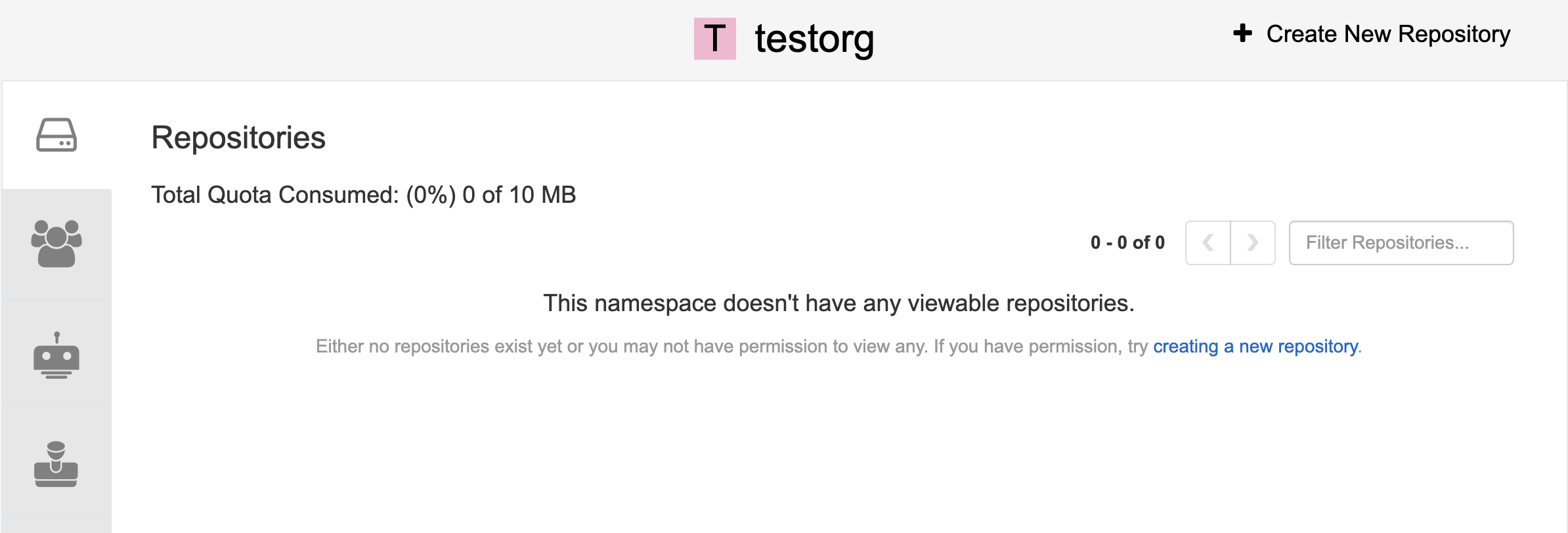

消費されたクォータ情報は、組織ページから直接入手することもできます。

最初に消費されたクォータ

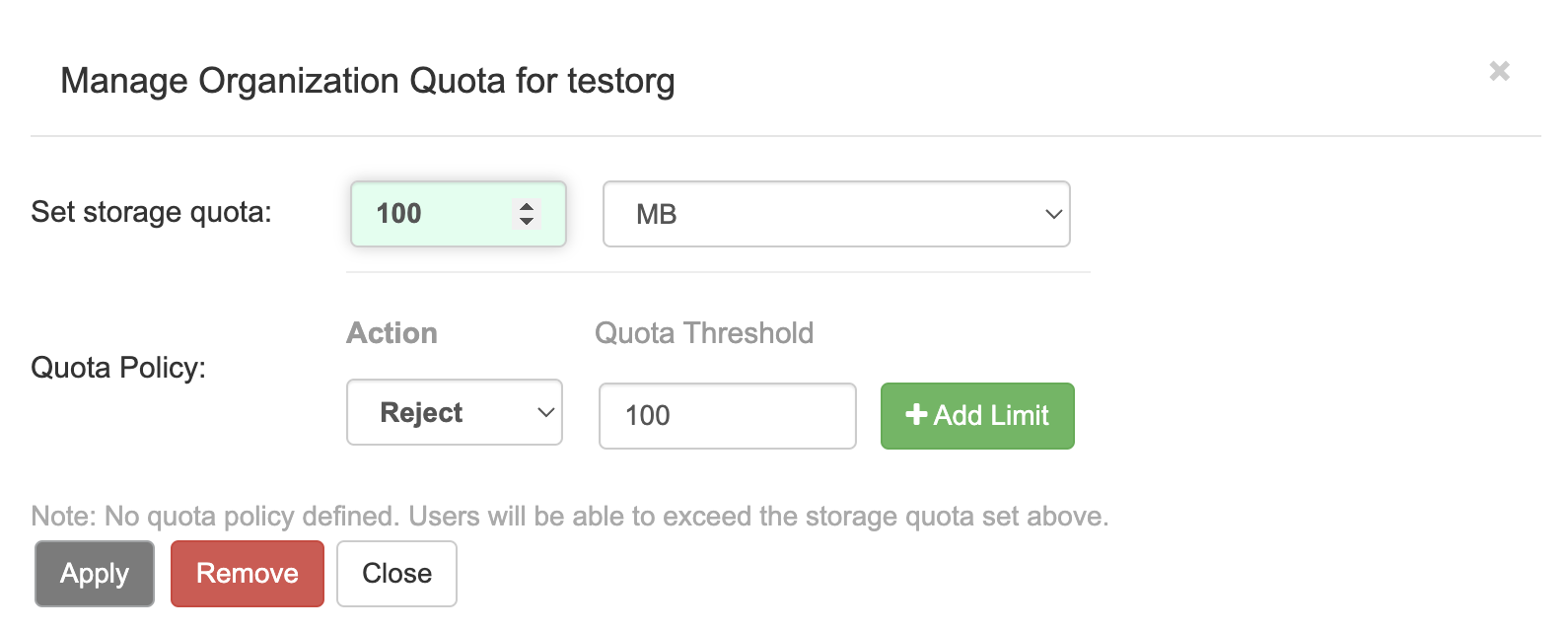

クォータを 100MB に増やすには、スーパーユーザーパネルの Manage Organizations タブに移動します。Options アイコンをクリックし、Configure Quota を選択して、クォータを 100 MB に設定します。Apply をクリックしてから Close をクリックします。

コマンドラインからサンプルイメージを組織にプッシュします。

サンプルコマンド

podman pull ubuntu:18.04 podman tag docker.io/library/ubuntu:18.04 example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/ubuntu:18.04 podman push --tls-verify=false example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/ubuntu:18.04

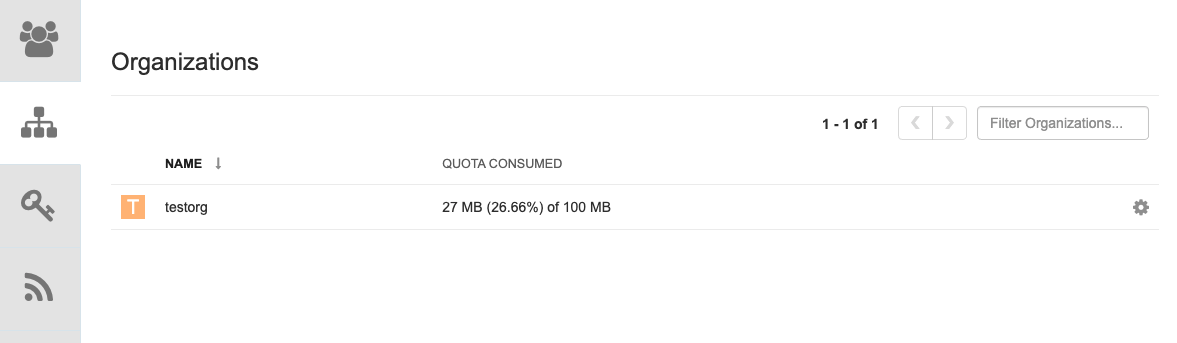

$ podman pull ubuntu:18.04 $ podman tag docker.io/library/ubuntu:18.04 example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/ubuntu:18.04 $ podman push --tls-verify=false example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/ubuntu:18.04Copy to Clipboard Copied! Toggle word wrap Toggle overflow スーパーユーザーパネルには、組織ごとに消費されたクォータが表示されます。

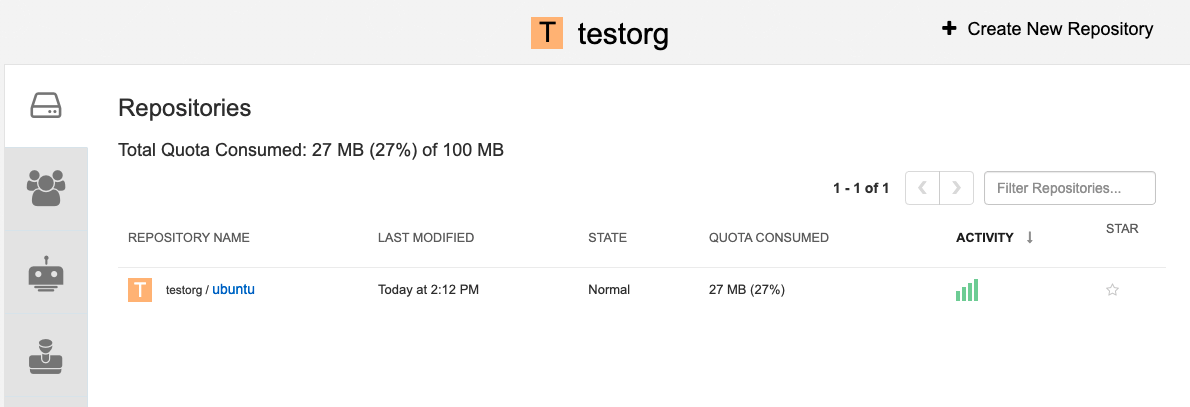

組織ページには、イメージで使用されているクォータの合計比率が表示されます。

最初のイメージで消費された合計クォータ

2 番目のイメージをプル、タグ付け、プッシュします。たとえば、

nginxです。サンプルコマンド

podman pull nginx podman tag docker.io/library/nginx example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/nginx podman push --tls-verify=false example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/nginx

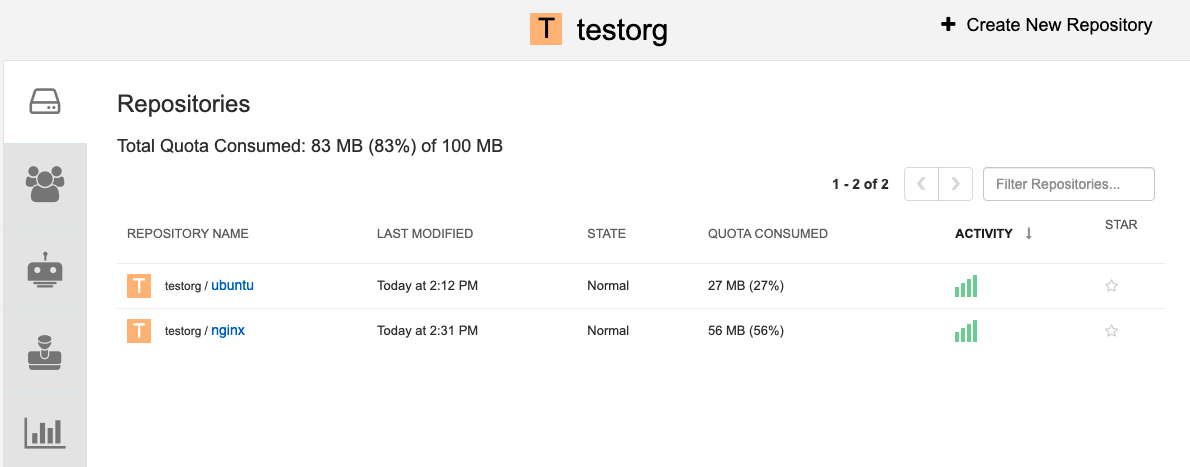

$ podman pull nginx $ podman tag docker.io/library/nginx example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/nginx $ podman push --tls-verify=false example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/nginxCopy to Clipboard Copied! Toggle word wrap Toggle overflow 組織ページには、その組織の各リポジトリーで使用されているクォータの合計比率が表示されます。

各リポジトリーで消費された合計クォータ

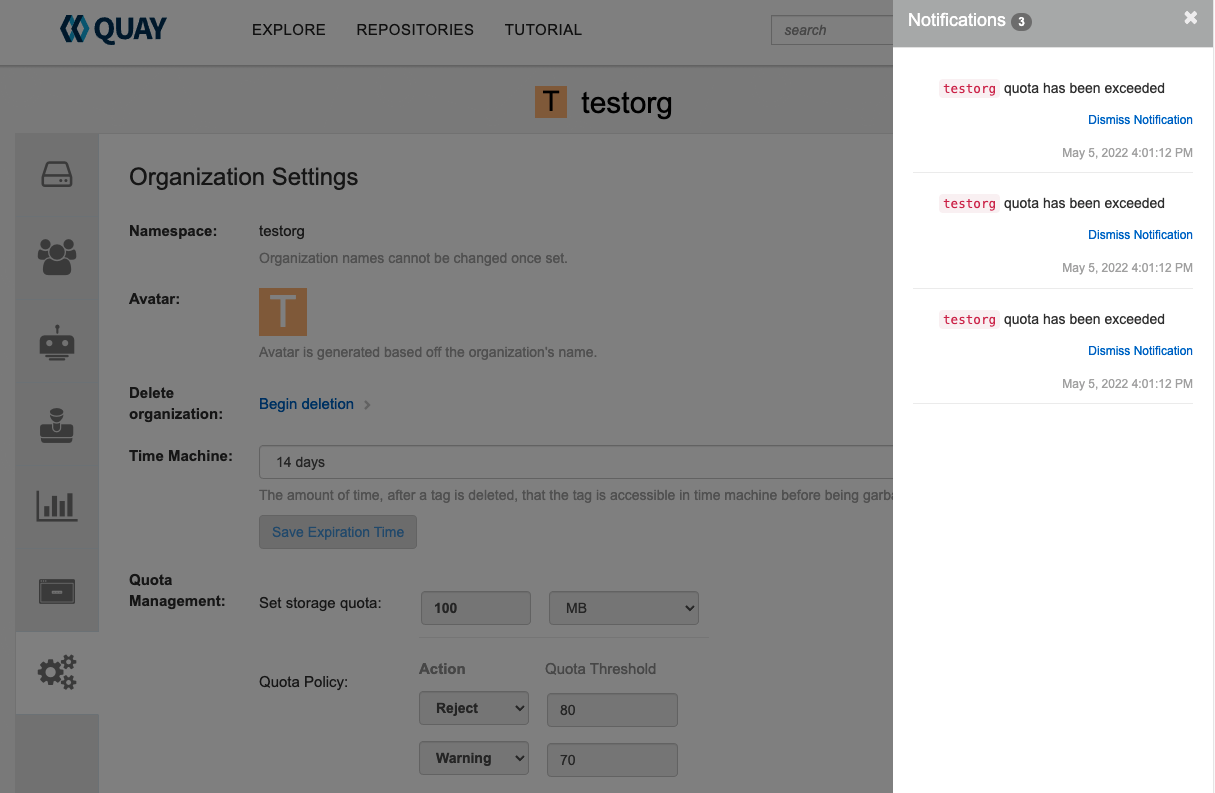

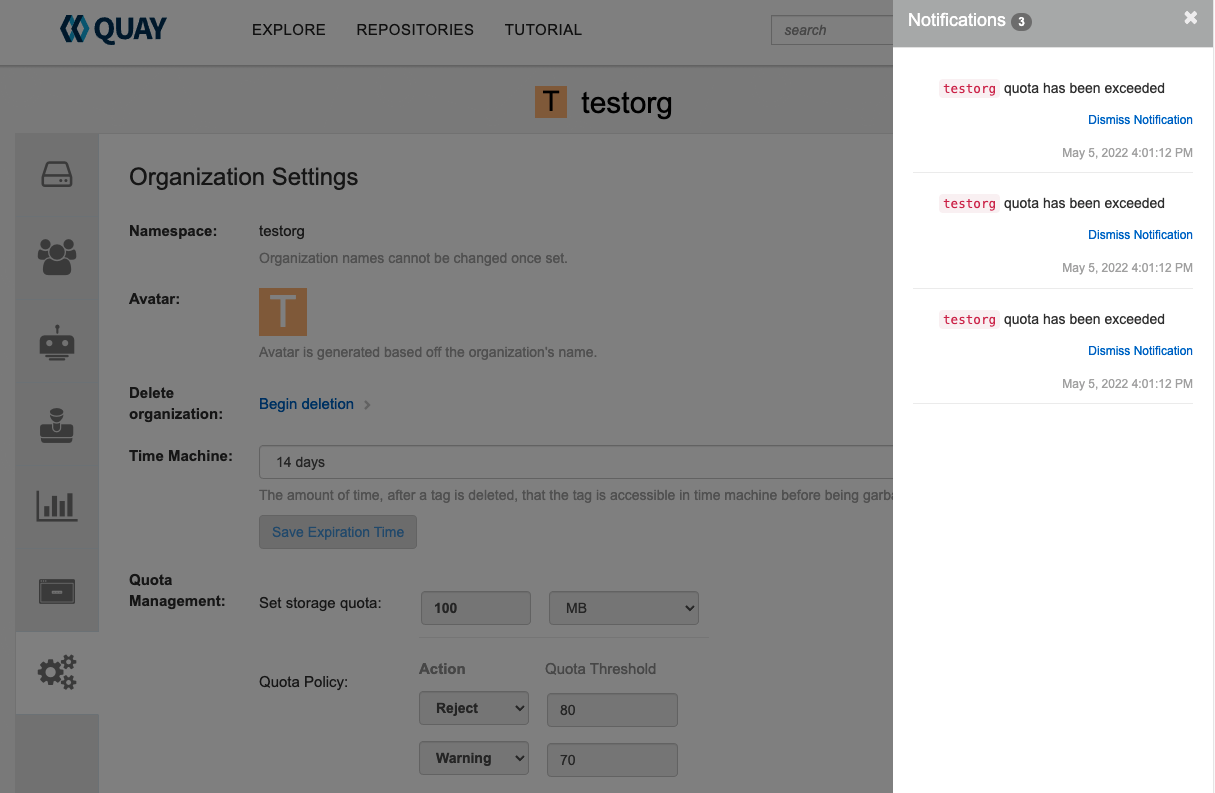

拒否 と 警告 の制限を作成します。

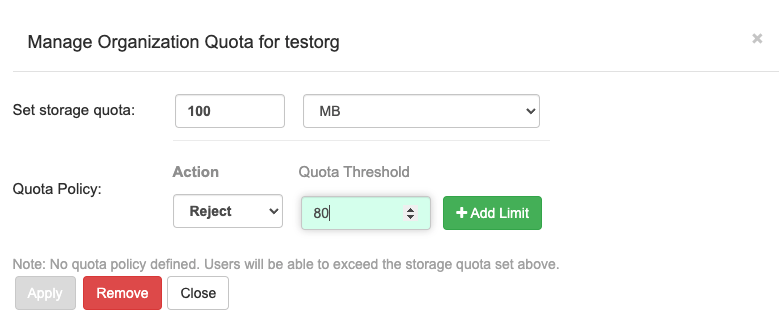

スーパーユーザーパネルから、Manage Organizations タブに移動します。組織の Options アイコンをクリックし、Configure Quota を選択します。Quota Policy セクションで、Action タイプを Reject に設定し、Quota Threshold を 80 に設定して、Add Limit をクリックします。

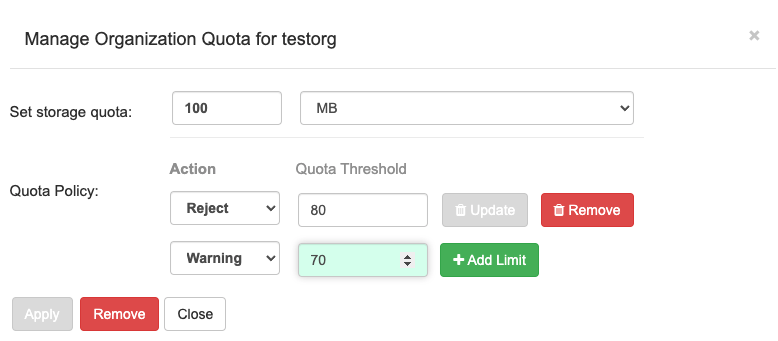

警告 制限を作成するには、Action タイプに Warning を選択し、Quota Threshold を 70 に設定して、Add Limit をクリックします。

クォータポップアップで Close をクリックします。制限は、Organization ページの Settings タブで表示できますが、編集することはできません。

拒否制限を超えたイメージをプッシュします。

拒否制限 (80%) が現在のリポジトリーサイズ (~83%) 未満に設定されているため、次のプッシュは自動的に拒否されます。

サンプルイメージプッシュ

podman pull ubuntu:20.04 podman tag docker.io/library/ubuntu:20.04 example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/ubuntu:20.04 podman push --tls-verify=false example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/ubuntu:20.04

$ podman pull ubuntu:20.04 $ podman tag docker.io/library/ubuntu:20.04 example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/ubuntu:20.04 $ podman push --tls-verify=false example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/ubuntu:20.04Copy to Clipboard Copied! Toggle word wrap Toggle overflow クォータを超えたときのサンプル出力

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 制限を超えると、UI に通知が表示されます。

クォータ通知

13.4. Red Hat Quay API を使用したクォータの確立

組織が最初に作成されたとき、割り当ては適用されていません。/api/v1/organization/{organization}/quota エンドポイントを使用します。

サンプルコマンド

curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota | jq

$ curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota | jq出力例

[]

[]13.4.1. クォータの設定

組織の割り当てを設定するには、データを /api/v1/organization/{orgname}/quota エンドポイントに POST します。以下はコマンド例です。

curl -k -X POST -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' -d '{"limit_bytes": 10485760}' https://example-registry-quay-quay-enterprise.apps.docs.quayteam.org/api/v1/organization/testorg/quota | jq

$ curl -k -X POST -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' -d '{"limit_bytes": 10485760}' https://example-registry-quay-quay-enterprise.apps.docs.quayteam.org/api/v1/organization/testorg/quota | jq出力例

"Created"

"Created"13.4.2. クォータの表示

適用されたクォータを確認するには、/api/v1/organization/{orgname}/quota エンドポイントからデータを GET します。

サンプルコマンド

curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota | jq

$ curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota | jq出力例

13.4.3. クォータの変更

既存の割り当てを変更する (ここでは 10MB から 100MB に) には、データを /api/v1/organization/{orgname}/quota/{quota_id} エンドポイントに PUT します。

サンプルコマンド

curl -k -X PUT -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' -d '{"limit_bytes": 104857600}' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota/1 | jq

$ curl -k -X PUT -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' -d '{"limit_bytes": 104857600}' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota/1 | jq出力例

13.4.4. イメージのプッシュ

消費されたストレージを確認するには、さまざまなイメージを組織にプッシュします。

13.4.4.1. ubuntu:18.04 のプッシュ

コマンドラインから組織に ubuntu:18.04 をプッシュします。

サンプルコマンド

podman pull ubuntu:18.04 podman tag docker.io/library/ubuntu:18.04 example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/ubuntu:18.04 podman push --tls-verify=false example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/ubuntu:18.04

$ podman pull ubuntu:18.04

$ podman tag docker.io/library/ubuntu:18.04 example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/ubuntu:18.04

$ podman push --tls-verify=false example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/ubuntu:18.0413.4.4.2. API を使用してクォータの使用状況の表示

消費されたストレージを表示するには、/api/v1/repository エンドポイントからデータを GET します。

サンプルコマンド

curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' 'https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/repository?last_modified=true&namespace=testorg&popularity=true&public=true"a=true' | jq

$ curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' 'https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/repository?last_modified=true&namespace=testorg&popularity=true&public=true"a=true' | jq出力例

13.4.4.3. 別のイメージをプッシュ

2 番目のイメージをプル、タグ付け、プッシュします。たとえば、

nginxです。サンプルコマンド

podman pull nginx podman tag docker.io/library/nginx example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/nginx podman push --tls-verify=false example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/nginx

$ podman pull nginx $ podman tag docker.io/library/nginx example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/nginx $ podman push --tls-verify=false example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/nginxCopy to Clipboard Copied! Toggle word wrap Toggle overflow 組織内のリポジトリーのクォータレポートを表示するには、/api/v1/repository エンドポイントを使用します。

サンプルコマンド

curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' 'https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/repository?last_modified=true&namespace=testorg&popularity=true&public=true"a=true'

$ curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' 'https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/repository?last_modified=true&namespace=testorg&popularity=true&public=true"a=true'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 組織の詳細でクォータ情報を表示するには、/api/v1/organization/{orgname} エンドポイントを使用します。

サンプルコマンド

curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' 'https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg' | jq

$ curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' 'https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg' | jqCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

13.4.5. クォータ制限を使用してプッシュの拒否

イメージプッシュが定義されたクォータ制限を超えると、ソフトチェックまたはハードチェックが発生します。

- ソフトチェックまたは 警告 の場合は、ユーザーに通知されます。

- ハードチェックまたは 拒否 の場合、プッシュは終了します。

13.4.5.1. 拒否および警告の制限の設定

拒否 および 警告 の制限を設定するには、データを /api/v1/organization/{orgname}/quota/{quota_id}/limit エンドポイントに POST します。

サンプル拒否制限コマンド

curl -k -X POST -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' -d '{"type":"Reject","threshold_percent":80}' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota/1/limit

$ curl -k -X POST -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' -d '{"type":"Reject","threshold_percent":80}' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota/1/limit警告制限コマンドの例

curl -k -X POST -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' -d '{"type":"Warning","threshold_percent":50}' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota/1/limit

$ curl -k -X POST -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' -d '{"type":"Warning","threshold_percent":50}' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota/1/limit13.4.5.2. 拒否および警告の制限の表示

拒否 および 警告 の制限を表示するには、/api/v1/Organization/{orgname}/quota エンドポイントを使用します。

クォータ制限の表示

curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota | jq

$ curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota | jqクォータ制限のサンプル出力

13.4.5.3. 拒否制限を超えたときにイメージをプッシュ

この例では、拒否制限 (80%) が現在のリポジトリーサイズ (~83%) 未満に設定されているため、次のプッシュは自動的に拒否されます。

コマンドラインからサンプルイメージを組織にプッシュします。

サンプルイメージプッシュ

podman pull ubuntu:20.04 podman tag docker.io/library/ubuntu:20.04 example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/ubuntu:20.04 podman push --tls-verify=false example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/ubuntu:20.04

$ podman pull ubuntu:20.04

$ podman tag docker.io/library/ubuntu:20.04 example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/ubuntu:20.04

$ podman push --tls-verify=false example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/testorg/ubuntu:20.04クォータを超えたときのサンプル出力

13.4.5.4. 制限を超えた場合の通知

制限を超えると、通知が表示されます。

クォータ通知

13.5. クォータ管理の制限