Red Hat Quay の管理

はじめに

Red Hat Quay レジストリーをデプロイメントした後、そのデプロイメントをさらに設定、管理する方法は数多くあります。ここでは、以下のようなトピックを取り上げています。

- Red Hat Quay の高度な設定

- Red Hat Quay の新リリースを知らせる通知の設定

- SSL/TLS 証明書による接続の保護

- アクションログのストレージの Elasticsearch へのダイレクト

- Clair によるイメージセキュリティースキャンの設定

- コンテナーセキュリティー Operator での Pod イメージのスキャン

- Quay Bridge Operator を使用した OpenShift Container Platform の Red Hat Quay への統合

- リポジトリーミラーリングによるイメージの反映

- BitTorrent サービスによる Red Hat Quay イメージの共有

- LDAP によるユーザーの認証

- Prometheus および Grafana メトリックの Quay の有効化

- Geo レプリケーションの設定

- Red Hat Quay のトラブルシューティング

Red Hat Quay 設定フィールドの完全なリストは、Red Hat Quay の設定 ページを参照してください。

第1章 Red Hat Quay の高度な設定

以下のいずれかの方法を使用して、初期デプロイメント後に Red Hat Quay を設定できます。

-

config.yamlファイルの編集。config.yamlファイルには、Red Hat Quay クラスターのほとんどの設定情報が含まれています。高度なチューニングや特定の機能を有効化するには、主にconfig.yamlファイルを直接編集する方法を使用します。 - Red Hat Quay API の使用一部の Red Hat Quay 機能は、API を介して設定できます。

このセクションでは、前述の各インターフェイスの使用方法と、高度な機能を使用してデプロイメントを設定する方法を説明します。

1.1. API を使用した Red Hat Quay の変更

Red Hat Quay API にアクセスする方法については、Red Hat Quay API ガイドを 参照してください。

1.2. config.yaml ファイルを編集して Red Hat Quay の変更

高度な機能は、config.yaml ファイルを直接編集することで実装できます。Red Hat Quay の機能および設定のすべての設定フィールドは、Red Hat Quay 設定ガイド で確認できます。

次の例は、config.yaml ファイルで直接変更できる設定です。この例を、他の機能および設定の config.yaml ファイルを編集する際の参考として使用してください。

1.2.1. Red Hat Quay サインインへの名前と会社の追加

FEATURE_USER_METADATA フィールドを True に設定すると、ユーザーは初めてサインインするときに名前と会社名の入力を求められます。これはオプションのフィールドですが、Red Hat Quay ユーザーに関する追加データを提供できます。

以下の手順を使用して、Red Hat Quay のサインインページに名前と会社を追加します。

手順

-

config.yamlファイルでFEATURE_USER_METADATA設定フィールドをTrueに追加または設定します。以下に例を示します。

# ... FEATURE_USER_METADATA: true # ...

# ...

FEATURE_USER_METADATA: true

# ...- Red Hat Quay を再デプロイします。

ログインを求めるプロンプトが出されたら、ユーザーは以下の情報を入力するよう要求されます。

第2章 コンフィグレーション API の利用

コンフィグレーションツールは、設定の構築、検証、バンドル、およびデプロイに使用できる 4 つのエンドポイントを示します。config-tool の API は、https://github.com/quay/config-tool/blob/master/pkg/lib/editor/API.md に記載されています。ここでは、API を使用して現在の設定を取得する方法と、変更した内容を検証する方法を説明します。

2.1. 初期設定値の取得

初めてコンフィグレーションツールを実行するときに、既存のコンフィグレーションがない場合は、デフォルトのコンフィグレーションを取得することができます。コンテナーをコンフィグモードで起動します。

sudo podman run --rm -it --name quay_config \ -p 8080:8080 \ registry.redhat.io/quay/quay-rhel8:v3.15.1 config secret

$ sudo podman run --rm -it --name quay_config \

-p 8080:8080 \

registry.redhat.io/quay/quay-rhel8:v3.15.1 config secret

デフォルトを取得するには、コンフィグレーション API の config エンドポイントを使用します。

curl -X GET -u quayconfig:secret http://quay-server:8080/api/v1/config | jq

$ curl -X GET -u quayconfig:secret http://quay-server:8080/api/v1/config | jq返される値は、JSON 形式によるデフォルト設定です。

2.2. 現在の設定の取得

すでに Quay レジストリーを設定してデプロイしている場合は、コンテナーを停止してコンフィグレーションモードで再起動し、既存のコンフィグレーションをボリュームとして読み込みます。

sudo podman run --rm -it --name quay_config \ -p 8080:8080 \ -v $QUAY/config:/conf/stack:Z \ registry.redhat.io/quay/quay-rhel8:v3.15.1 config secret

$ sudo podman run --rm -it --name quay_config \

-p 8080:8080 \

-v $QUAY/config:/conf/stack:Z \

registry.redhat.io/quay/quay-rhel8:v3.15.1 config secret

現在の設定を取得するには、API の config エンドポイントを使用します。

curl -X GET -u quayconfig:secret http://quay-server:8080/api/v1/config | jq

$ curl -X GET -u quayconfig:secret http://quay-server:8080/api/v1/config | jq返される値は、データベースと Redis の設定データを含む、JSON 形式の現在の設定です。

2.3. API による設定の検証

設定を検証するには、config/validate エンドポイントに設定を投稿します。

返される値は、設定で見つかったエラーを含む配列です。設定が有効であれば、空の配列 [] が返されます。

2.4. 必須項目の決定

空の設定構造を config/validate エンドポイントに投稿することで、必須フィールドを決定することができます。

返される値は、どのフィールドが必須であるかを示す配列です。

第3章 Red Hat Quay のリリース通知の取得

Red Hat Quay の最新リリースや Red Hat Quay に関連するその他の変更を確認するには、Red Hat Customer Portal で更新通知に登録してください。通知に登録すると、Red Hat Quay の新しいバージョン、ドキュメントの更新、その他の Red Hat Quay のニュースをお知らせする通知を受け取ることができます。

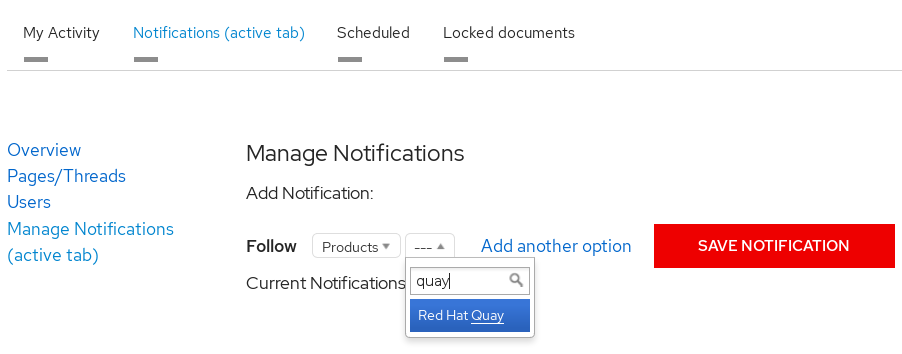

- Red Hat カスタマーアカウントの認証情報を使用して Red Hat カスタマーポータル にログインします。

-

ユーザー名 (右上隅) を選択して、Red Hat アカウントとカスタマーポータルの選択を表示します。

- Notifications を選択します。あなたのプロフィール活動ページが表示されます。

- Notifications タブを選択します。

- Manage Notifications を選択します。

- Follow を選択し、ドロップダウンボックスから Product を選択します。

-

製品の横にあるドロップダウンボックスで、Red Hat Quay を検索して選択します。

- SAVE NOTIFICATION ボタンを選択します。今後、Red Hat Quay 製品に新しいリリースなどの変更があった場合には、通知が届きます。

第4章 SSL を使用した Red Hat Quay への接続の保護

4.1. SSL/TLS の使用

SSL/TLS の使用 に関するドキュメントが改訂され、Red Hat Quay のセキュリティー保護 に移動されました。この章は、Red Hat Quay の今後のバージョンでは削除される予定です。

第5章 Elasticsearch と Splunk のアクションログストレージの設定

デフォルトでは、使用状況ログが Red Hat Quay データベースに保存され、Web UI を通じて組織レベルおよびリポジトリーレベルで公開されます。ログエントリーを見るには、適切な管理者権限が必要です。ログに記録された操作が大量にあるデプロイメントの場合は、Red Hat Quay データベースバックエンドの代わりに Elasticsearch と Splunk に使用ログを保存できます。

5.1. Elasticsearch のアクションログストレージの設定

Elasticsearch のアクションログストレージを設定するには、カスタマイズ可能なコンポーネントとして Red Hat Quay に含まれていないため、独自の Elasticsearch スタックを提供する必要があります。

Elasticsearch ロギングの有効化は、Red Hat Quay のデプロイメント中、またはデプロイメント後に config.yaml ファイルを更新することで実行できます。設定すると、Web UI を介してリポジトリーと組織の使用状況ログへのアクセスが引き続き提供されます。

Elasticsearch のアクションログストレージを設定するには、次の手順を使用します。

手順

- Elasticsearch のアカウントを取得します。

Red Hat Quay

config.yamlファイルを更新して、以下の情報を含めます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ログデータを処理する方法。

- 2

- Elasticsearch または Kinesis のいずれかを選択して、ログを AWS 上の中間 Kinesis ストリームに送信します。Kinesis から Elasticsearch にログを送信するには、Logstash などの独自のパイプラインを設定する必要があります。

- 3

- Elasticsearch サービスを提供するシステムのホスト名または IP アドレス。

- 4

- 入力したホスト上で Elasticsearch サービスを提供するポート番号。ポートが、Red Hat Quay レジストリーを実行しているすべてのシステムからアクセス可能でなければならないことに注意してください。デフォルトは TCP ポート

9200です。 - 5

- 必要に応じて、Elasticsearch サービスにアクセスするために必要なアクセスキー。

- 6

- 必要に応じて、Elasticsearch サービスにアクセスするために必要なシークレットキー。

- 7

- Elasticsearch に SSL/TLS を使用するかどうか。デフォルトは

Trueに設定されます。 - 8

- ログエントリーにアタッチする接頭辞を選択します。

- 9

- AWS 上で実行している場合は、AWS リージョンを設定します (それ以外の場合は空白のままにします)。

オプション: ログプロデューサーとして Kinesis を使用している場合は、

config.yamlファイルに次のフィールドを含める必要があります。kinesis_stream_config: stream_name: <kinesis_stream_name> access_key: <aws_access_key> secret_key: <aws_secret_key> aws_region: <aws_region>kinesis_stream_config: stream_name: <kinesis_stream_name>1 access_key: <aws_access_key>2 secret_key: <aws_secret_key>3 aws_region: <aws_region>4 Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

config.yamlファイルを保存し、Red Hat Quay デプロイメントを再起動します。

5.2. Splunk のアクションログストレージの設定

Splunk は、Red Hat Quay データのログ分析を提供できる Elasticsearch の代替手段です。

Splunk ロギングの有効化は、Red Hat Quay のデプロイメント中またはデプロイメント後に設定ツールを使用して行うことができます。設定には、アクションログを Splunk に直接転送するか、Splunk HTTP Event Collector (HEC) に転送するかのオプションが含まれます。

Red Hat Quay デプロイメントで Splunk を有効にするには、次の手順を使用します。

5.2.1. Splunk のインストールとユーザー名の作成

Splunk 認証情報をインストールして作成するには、次の手順を使用します。

手順

- Splunk に移動し、必要な認証情報を入力して、Splunk アカウントを作成します。

- Splunk Enterprise Free Trial ページに移動し、プラットフォームとインストールパッケージを選択して、Download Now をクリックします。

-

マシンに Splunk ソフトウェアをインストールします。プロンプトが表示されたら、

splunk_adminなどのユーザー名とパスワードを作成します。 -

ユーザー名とパスワードを作成すると、Splunk 導入用のローカルホスト URL (例:

http://<sample_url>.remote.csb:8000/) が提供されます。お好みのブラウザーで URL を開きます。 - インストール時に作成したユーザー名とパスワードを使用してログインします。Splunk UI にリダイレクトします。

5.2.2. Splunk トークンの生成

次のいずれかの手順を使用して、Splunk のベアラートークンを作成します。

5.2.2.1. Splunk UI を使用した Splunk トークンの生成

Splunk UI を使用して Splunk のベアラートークンを作成するには、次の手順を実行します。

前提条件

- Splunk をインストールし、ユーザー名を作成している。

手順

- Splunk UI で、Settings → Tokens に移動します。

- Enable Token Authentication をクリックします。

- 必要に応じて、Token Settings をクリックし、Token Authentication を選択して、Token Authentication が有効になっていることを確認します。

- オプション: トークンの有効期限を設定します。このデフォルトは 30 日です。

- Save をクリックします。

- New Token をクリックします。

- User および Audience の情報を入力します。

- オプション: Expiration および Not Before 情報を設定します。

Create をクリックします。トークンが Token ボックスに表示されます。トークンをすぐにコピーします。

重要トークンをコピーする前にボックスを閉じた場合は、新しいトークンを作成する必要があります。New Token ウィンドウを閉じると、トークン全体が使用できなくなります。

5.2.2.2. CLI を使用した Splunk トークンの生成

CLI を使用して Splunk のベアラートークンを作成するには、次の手順を実行します。

前提条件

- Splunk をインストールし、ユーザー名を作成している。

手順

CLI で次の

CURLコマンドを入力してトークン認証を有効にし、Splunk ユーザー名とパスワードを渡します。curl -k -u <username>:<password> -X POST <scheme>://<host>:<port>/services/admin/token-auth/tokens_auth -d disabled=false

$ curl -k -u <username>:<password> -X POST <scheme>://<host>:<port>/services/admin/token-auth/tokens_auth -d disabled=falseCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次の

CURLコマンドを入力し、Splunk ユーザー名とパスワードを渡してトークンを作成します。curl -k -u <username>:<password> -X POST <scheme>://<host>:<port>/services/authorization/tokens?output_mode=json --data name=<username> --data audience=Users --data-urlencode expires_on=+30d

$ curl -k -u <username>:<password> -X POST <scheme>://<host>:<port>/services/authorization/tokens?output_mode=json --data name=<username> --data audience=Users --data-urlencode expires_on=+30dCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 生成されたベアラートークンを保存します。

5.2.3. Splunk を使用するための Red Hat Quay の設定

Splunk または Splunk HTTP Event Collector (HEC) を使用するように Red Hat Quay を設定するには、次の手順に従います。

前提条件

- Splunk をインストールし、ユーザー名を作成している。

- Splunk ベアラートークンを生成している。

手順

Splunk または Splunk HTTP Event Collector (HEC) を使用するように Red Hat Quay を設定します。

Splunk を使用する場合は、Red Hat Quay の

config.yamlファイルを開き、次の設定フィールドを追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- String。Splunk クラスターのエンドポイント。

- 2

- 整数。Splunk 管理クラスターのエンドポイントポート。Splunk GUI でホストされるポートとは異なります。Splunk UI の Settings → Server Settings → General Settings にあります。

- 3

- String。Splunk 用に生成されたベアラートークン。

- 4

- String。Splunk サービスにアクセスするための URL スキーム。Splunk が TLS/SSL を使用するように設定されている場合、これは

httpsである必要があります。 - 5

- ブール値。TLS/SSL を有効にするかどうか。デフォルトは

Trueに設定されます。 - 6

- 文字列。Splunk インデックスの接頭辞。新しいインデックスまたは使用済みのインデックスを使用できます。Splunk UI から作成できます。

- 7

- String。TLS/SSL 検証用の認証局 (CA) を含む単一の

.pemファイルへの相対コンテナーパス。

Splunk HEC を使用する場合は、Red Hat Quay の

config.yamlファイルを開き、次の設定フィールドを追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Splunk HEC を設定する場合は

splunk_hecを指定します。 - 2

- Splunk HTTP Event Collector のアクションログ設定のログモデル設定。

- 3

- Splunk クラスターのエンドポイント。

- 4

- Splunk 管理クラスターのエンドポイントポート。

- 5

- Splunk の HEC トークン。

- 6

- Splunk サービスにアクセスするための URL スキーム。Splunk が SSL/TLS の背後にある場合は、

httpsにする必要があります。 - 7

- ブール値。HTTPS 接続の SSL/TLS 検証を有効 (true) または無効 (false) にします。

- 8

- 使用する Splunk インデックス。

- 9

- このイベントをログに記録するホスト名。

- 10

- 使用する Splunk

sourcetypeの名前。

ssl_ca_pathを設定している場合は、Red Hat Quay が信頼するように SSL/TLS 証明書を設定する必要があります。-

Red Hat Quay のスタンドアロンデプロイメントを使用している場合は、証明書ファイルを

extra_ca_certsディレクトリー内、または相対コンテナーパス内に配置してssl_ca_pathで指定することで、SSL/TLS 証明書を提供できます。 Red Hat Quay Operator を使用している場合は、Splunk サーバーの認証局 (CA) を含む設定バンドルのシークレットを作成します。以下に例を示します。

oc create secret generic --from-file config.yaml=./config_390.yaml --from-file extra_ca_cert_splunkserver.crt=./splunkserver.crt config-bundle-secret

$ oc create secret generic --from-file config.yaml=./config_390.yaml --from-file extra_ca_cert_splunkserver.crt=./splunkserver.crt config-bundle-secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow config.yamlにconf/stack/extra_ca_certs/splunkserver.crtファイルを指定します。以下に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

Red Hat Quay のスタンドアロンデプロイメントを使用している場合は、証明書ファイルを

5.2.4. アクションログの作成

次の手順を使用して、アクションログを Splunk に転送できるユーザーアカウントを作成します。

Red Hat Quay アクションログを表示するには、Splunk UI を使用する必要があります。現時点では、Red Hat Quay 使用状況ログ ページでの Splunk アクションログの表示はサポートされておらず、次のメッセージが返されます。Method not implemented.Splunk does not support log lookups

前提条件

- Splunk をインストールし、ユーザー名を作成している。

- Splunk ベアラートークンを生成している。

-

Splunk を有効にするように Red Hat Quay

config.yamlファイルを設定している。

手順

- Red Hat Quay デプロイメントにログインします。

- Splunk のアクションログの作成に使用する組織の名前をクリックします。

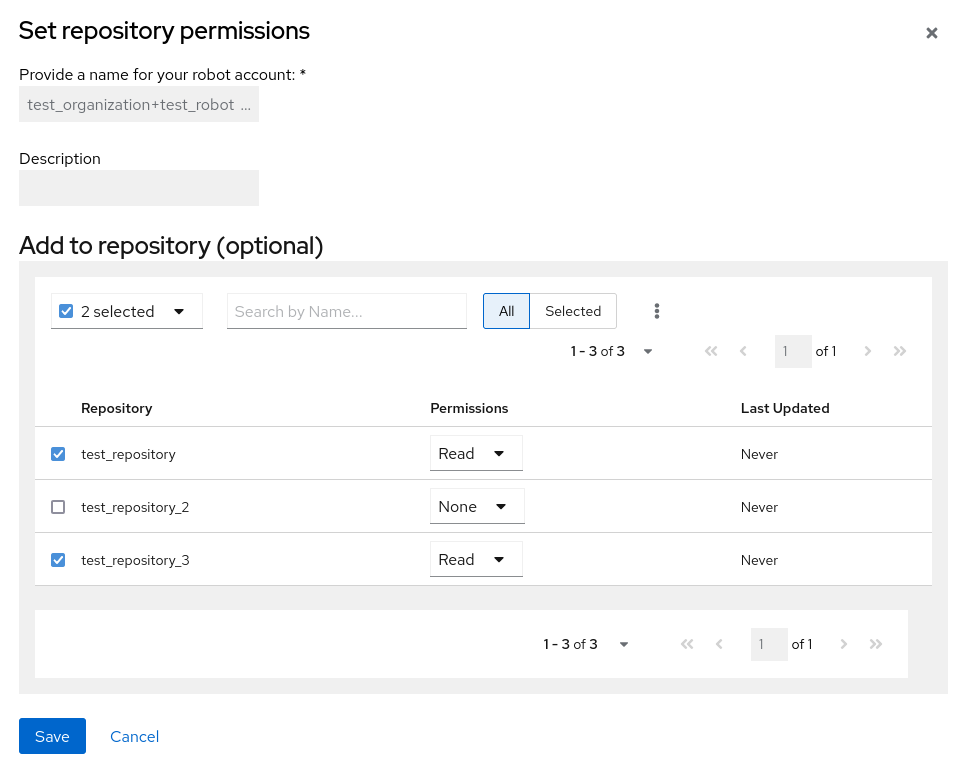

- ナビゲーションウィンドウで、Robot Accounts → Create Robot Account をクリックします。

-

プロンプトが表示されたら、ロボットアカウントの名前 (例:

spunkrobotaccount) を入力して、Create robot account をクリックします。 - ブラウザーで Splunk UI を開きます。

- Search and Reporting をクリックします。

検索バーにインデックスの名前 (例:

<splunk_log_index_name>) を入力し、Enter を押します。検索結果が Splunk UI に表示されます。ログは JSON 形式で転送されます。応答は以下のようになります。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3. 使用状況ログについて

デフォルトでは、使用状況ログは Red Hat Quay データベースに保存されます。ログは、Web UI、組織レベル、リポジトリーレベル、および スーパーユーザー管理パネル を通じて公開されます。

データベースのログには、アカウントプランの変更、ユーザーアクション、一般的な操作など、Red Hat Quay のさまざまなイベントが記録されます。ログエントリーには、実行されたアクション (kind_id)、アクションを実行したユーザー (account_id または performer_id)、タイムスタンプ (datetime)、およびアクションに関連付けられたその他の関連データ (metadata_json) などの情報が含まれています。

5.3.1. データベースログの表示

次の手順では、PostgreSQL データベースに保存されているリポジトリーログを表示する方法を示します。

前提条件

- 管理者権限がある。

-

psqlCLI ツールがインストールされている。

手順

次のコマンドを入力して、Red Hat Quay PostgreSQL データベースにログインします。

psql -h <quay-server.example.com> -p 5432 -U <user_name> -d <database_name>

$ psql -h <quay-server.example.com> -p 5432 -U <user_name> -d <database_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

psql (16.1, server 13.7) Type "help" for help.

psql (16.1, server 13.7) Type "help" for help.Copy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: PostgreSQL データベースのテーブルリストを表示するには、次のコマンドを入力します。

quay=> \dt

quay=> \dtCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力すると、ログ情報を返すために必要な

repository_idsのリストが返されます。quay=> SELECT id, name FROM repository;

quay=> SELECT id, name FROM repository;Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow logentry3リレーションを使用していずれかのリポジトリーに関するログ情報を表示するには、次のコマンドを入力します。SELECT * FROM logentry3 WHERE repository_id = <repository_id>;

SELECT * FROM logentry3 WHERE repository_id = <repository_id>;Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

id | kind_id | account_id | performer_id | repository_id | datetime | ip | metadata_json 59 | 14 | 2 | 1 | 6 | 2024-05-13 15:51:01.897189 | 192.168.1.130 | {"repo": "api-repo", "namespace": "test-org"}id | kind_id | account_id | performer_id | repository_id | datetime | ip | metadata_json 59 | 14 | 2 | 1 | 6 | 2024-05-13 15:51:01.897189 | 192.168.1.130 | {"repo": "api-repo", "namespace": "test-org"}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 上記の例では、次の情報が返されます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3.2. ログエントリー kind_ids

次の表は、Red Hat Quay のアクションに関連付けられている kind_ids を表しています。

| kind_id | アクション | 説明 |

|---|---|---|

| 1 | account_change_cc | クレジットカード情報の変更。 |

| 2 | account_change_password | アカウントパスワードの変更。 |

| 3 | account_change_plan | アカウントプランの変更。 |

| 4 | account_convert | アカウント変換。 |

| 5 | add_repo_accesstoken | リポジトリーへのアクセストークンの追加。 |

| 6 | add_repo_notification | リポジトリーへの通知の追加。 |

| 7 | add_repo_permission | リポジトリーへの権限の追加。 |

| 8 | add_repo_webhook | リポジトリーへの Webhook の追加。 |

| 9 | build_dockerfile | Dockerfile の構築。 |

| 10 | change_repo_permission | リポジトリーの権限の変更。 |

| 11 | change_repo_visibility | リポジトリーの可視性の変更。 |

| 12 | create_application | アプリケーションの作成。 |

| 13 | create_prototype_permission | プロトタイプの権限の作成。 |

| 14 | create_repo | リポジトリーの作成。 |

| 15 | create_robot | ロボット (サービスアカウントまたはボット) の作成。 |

| 16 | create_tag | タグの作成。 |

| 17 | delete_application | アプリケーションの削除。 |

| 18 | delete_prototype_permission | プロトタイプの権限の削除。 |

| 19 | delete_repo | リポジトリーの削除。 |

| 20 | delete_repo_accesstoken | リポジトリーからのアクセストークンの削除。 |

| 21 | delete_repo_notification | リポジトリーからの通知の削除。 |

| 22 | delete_repo_permission | リポジトリーからの権限の削除。 |

| 23 | delete_repo_trigger | リポジトリートリガーの削除。 |

| 24 | delete_repo_webhook | リポジトリーからの Webhook の削除。 |

| 25 | delete_robot | ロボットの削除。 |

| 26 | delete_tag | タグの削除。 |

| 27 | manifest_label_add | マニフェストへのラベルの追加。 |

| 28 | manifest_label_delete | マニフェストからのラベルの削除。 |

| 29 | modify_prototype_permission | プロトタイプの権限の変更。 |

| 30 | move_tag | タグの移動。 |

| 31 | org_add_team_member | チームへのメンバーの追加。 |

| 32 | org_create_team | 組織内のチームの作成。 |

| 33 | org_delete_team | 組織内のチームの削除。 |

| 34 | org_delete_team_member_invite | チームメンバーの招待の削除。 |

| 35 | org_invite_team_member | 組織内のチームへのメンバー招待。 |

| 36 | org_remove_team_member | チームからのメンバーの削除。 |

| 37 | org_set_team_description | チームの説明の設定。 |

| 38 | org_set_team_role | チームの役割の設定。 |

| 39 | org_team_member_invite_accepted | チームメンバーの招待の承諾。 |

| 40 | org_team_member_invite_declined | チームメンバーの招待の辞退。 |

| 41 | pull_repo | リポジトリーからのプル。 |

| 42 | push_repo | リポジトリーへのプッシュ。 |

| 43 | regenerate_robot_token | ロボットトークンの再生成。 |

| 44 | repo_verb | 一般的なリポジトリーアクション (詳細は他の場所で定義されている場合があります)。 |

| 45 | reset_application_client_secret | アプリケーションのクライアントシークレットのリセット。 |

| 46 | revert_tag | タグを元に戻す操作。 |

| 47 | service_key_approve | サービスキーの承認。 |

| 48 | service_key_create | サービスキーの作成。 |

| 49 | service_key_delete | サービスキーの削除。 |

| 50 | service_key_extend | サービスキーの拡張。 |

| 51 | service_key_modify | サービスキーの変更。 |

| 52 | service_key_rotate | サービスキーのローテーション。 |

| 53 | setup_repo_trigger | リポジトリートリガーの設定。 |

| 54 | set_repo_description | リポジトリーの説明の設定。 |

| 55 | take_ownership | リソースの所有権の取得。 |

| 56 | update_application | アプリケーションの更新。 |

| 57 | change_repo_trust | リポジトリーの信頼レベルの変更。 |

| 58 | reset_repo_notification | リポジトリー通知のリセット。 |

| 59 | change_tag_expiration | タグの有効期限の変更。 |

| 60 | create_app_specific_token | アプリケーション固有のトークンの作成。 |

| 61 | revoke_app_specific_token | アプリケーション固有のトークンの取り消し。 |

| 62 | toggle_repo_trigger | リポジトリートリガーのオン/オフの切り替え。 |

| 63 | repo_mirror_enabled | リポジトリーミラーリングの有効化。 |

| 64 | repo_mirror_disabled | リポジトリーのミラーリングの無効化。 |

| 65 | repo_mirror_config_changed | リポジトリーミラーリングの設定の変更。 |

| 66 | repo_mirror_sync_started | リポジトリーミラーの同期の開始。 |

| 67 | repo_mirror_sync_failed | リポジトリーミラーの同期が失敗しました。 |

| 68 | repo_mirror_sync_success | リポジトリーミラーの同期が成功しました。 |

| 69 | repo_mirror_sync_now_requested | 即時リポジトリーミラー同期が要求されました。 |

| 70 | repo_mirror_sync_tag_success | リポジトリーミラータグの同期が成功しました。 |

| 71 | repo_mirror_sync_tag_failed | リポジトリーミラータグの同期が失敗しました。 |

| 72 | repo_mirror_sync_test_success | リポジトリーミラー同期テストが成功しました。 |

| 73 | repo_mirror_sync_test_failed | リポジトリーミラー同期テストが失敗しました。 |

| 74 | repo_mirror_sync_test_started | リポジトリーミラー同期テストが開始されました。 |

| 75 | change_repo_state | リポジトリーの状態の変更。 |

| 76 | create_proxy_cache_config | プロキシーキャッシュ設定の作成。 |

| 77 | delete_proxy_cache_config | プロキシーキャッシュ設定の削除。 |

| 78 | start_build_trigger | ビルドトリガーの開始。 |

| 79 | cancel_build | ビルドのキャンセル。 |

| 80 | org_create | 組織の作成。 |

| 81 | org_delete | 組織の削除。 |

| 82 | org_change_email | 組織のメールアドレスの変更。 |

| 83 | org_change_invoicing | 組織の請求の変更。 |

| 84 | org_change_tag_expiration | 組織タグの有効期限の変更。 |

| 85 | org_change_name | 組織名の変更。 |

| 86 | user_create | ユーザーの作成。 |

| 87 | user_delete | ユーザーの削除。 |

| 88 | user_disable | ユーザーの無効化。 |

| 89 | user_enable | ユーザーの有効化。 |

| 90 | user_change_email | ユーザーのメールアドレスの変更。 |

| 91 | user_change_password | ユーザーパスワードの変更。 |

| 92 | user_change_name | ユーザー名の変更。 |

| 93 | user_change_invoicing | ユーザーの請求の変更。 |

| 94 | user_change_tag_expiration | ユーザータグの有効期限の変更。 |

| 95 | user_change_metadata | ユーザーメタデータの変更。 |

| 96 | user_generate_client_key | ユーザーのクライアントキーの生成。 |

| 97 | login_success | ログインの成功。 |

| 98 | logout_success | ログアウトの成功。 |

| 99 | permanently_delete_tag | タグの完全な削除。 |

| 100 | autoprune_tag_delete | 自動プルーニングタグの削除。 |

| 101 | create_namespace_autoprune_policy | namespace の自動プルーニングポリシーの作成。 |

| 102 | update_namespace_autoprune_policy | namespace の自動プルーニングポリシーの更新。 |

| 103 | delete_namespace_autoprune_policy | namespace の自動プルーニングポリシーの削除。 |

| 104 | login_failure | ログイン試行の失敗。 |

第6章 Clair セキュリティースキャナー

6.1. Clair 脆弱性データベース

Clair は、次の脆弱性データベースを使用して、イメージの問題を報告します。

- Ubuntu Oval データベース

- Debian Security Tracker

- Red Hat Enterprise Linux (RHEL) Oval データベース

- SUSE Oval データベース

- Oracle Oval データベース

- アルパイン SecDB データベース

- VMware Photon OS データベース

- Amazon Web Services (AWS) UpdateInfo

- Open Source Vulnerability (OSV) Database

Clair がさまざまなデータベースでセキュリティーマッピングを行う方法は、Claircore Severity Mapping を参照してください。

6.1.1. Clair の Open Source Vulnerability (OSV) データベースに関する情報

Open Source Vulnerability (OSV) は、オープンソースソフトウェアのセキュリティー脆弱性の追跡と管理に重点を置いた脆弱性データベースおよび監視サービスです。

OSV は、オープンソースプロジェクトにおける既知のセキュリティー脆弱性の包括的かつ最新のデータベースを提供します。ソフトウェア開発で使用されるライブラリー、フレームワーク、その他のコンポーネントを含む、幅広いオープンソースソフトウェアを対象としています。対象エコシステムの完全なリストは、定義されているエコシステム を参照してください。

Clair は、Open Source Vulnerability (OSV) データベースを通じて、golang、java、および ruby エコシステムの脆弱性とセキュリティー情報も報告します。

開発者や組織は、OSV を活用することで、使用するオープンソースコンポーネントのセキュリティー脆弱性をプロアクティブに監視して対処できるため、プロジェクトにおけるセキュリティー違反やデータ漏洩のリスクを軽減できます。

OSV の詳細は、OSV Web サイト を参照してください。

6.2. スタンドアロンの Red Hat Quay デプロイメントでの Clair のセットアップ

スタンドアロンの Red Hat Quay デプロイメントの場合、Clair を手動でセットアップできます。

手順

Red Hat Quay インストールディレクトリーに、Clair データベースデータ用の新しいディレクトリーを作成します。

mkdir /home/<user-name>/quay-poc/postgres-clairv4

$ mkdir /home/<user-name>/quay-poc/postgres-clairv4Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、

postgres-clairv4ファイルに適切な権限を設定します。setfacl -m u:26:-wx /home/<user-name>/quay-poc/postgres-clairv4

$ setfacl -m u:26:-wx /home/<user-name>/quay-poc/postgres-clairv4Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、Clair PostgreSQL データベースをデプロイします。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Clair デプロイメント用に PostgreSQL

uuid-osspモジュールをインストールします。sudo podman exec -it postgresql-clairv4 /bin/bash -c 'echo "CREATE EXTENSION IF NOT EXISTS \"uuid-ossp\"" | psql -d clair -U postgres'

$ sudo podman exec -it postgresql-clairv4 /bin/bash -c 'echo "CREATE EXTENSION IF NOT EXISTS \"uuid-ossp\"" | psql -d clair -U postgres'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

CREATE EXTENSION

CREATE EXTENSIONCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記Clair では、

uuid-ossp拡張機能を PostgreSQL データベースに追加する必要があります。適切な権限を持つユーザーの場合は、拡張機能を作成すると、Clair によって自動的に追加されます。ユーザーが適切な権限を持っていない場合は、Clair を開始する前に拡張機能を追加する必要があります。拡張機能が存在しない場合は、Clair が起動しようとすると、

ERROR: Please load the "uuid-ossp" extension.(SQLSTATE 42501)エラーが発生します。実行中の場合は、

Quayコンテナーを停止し、設定モードで再始動して、既存の設定をボリュームとしてロードします。sudo podman run --rm -it --name quay_config \ -p 80:8080 -p 443:8443 \ -v $QUAY/config:/conf/stack:Z \ registry.redhat.io/quay/quay-rhel8:v3.15.1 config secret

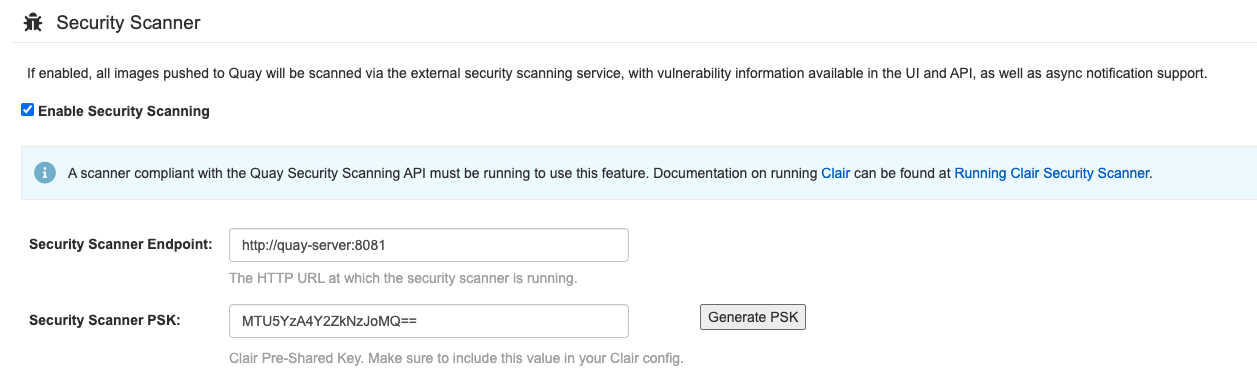

$ sudo podman run --rm -it --name quay_config \ -p 80:8080 -p 443:8443 \ -v $QUAY/config:/conf/stack:Z \ registry.redhat.io/quay/quay-rhel8:v3.15.1 config secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 設定ツールにログインし、UI の Security Scanner セクションで Enable Security Scanning をクリックします。

-

quay-serverシステムでまだ使用されていないポート (8081など) を使用して、Clair の HTTP エンドポイントを設定します。 Generate PSK ボタンを使用して、事前共有キー (PSK) を作成します。

セキュリティースキャナー UI

-

Red Hat Quay の

config.yamlファイルを検証してダウンロードし、設定エディターを実行しているQuayコンテナーを停止します。 新しい設定バンドルを Red Hat Quay インストールディレクトリーに展開します。次に例を示します。

tar xvf quay-config.tar.gz -d /home/<user-name>/quay-poc/

$ tar xvf quay-config.tar.gz -d /home/<user-name>/quay-poc/Copy to Clipboard Copied! Toggle word wrap Toggle overflow Clair 設定ファイル用のフォルダーを作成します。次に例を示します。

mkdir /etc/opt/clairv4/config/

$ mkdir /etc/opt/clairv4/config/Copy to Clipboard Copied! Toggle word wrap Toggle overflow Clair 設定フォルダーに移動します。

cd /etc/opt/clairv4/config/

$ cd /etc/opt/clairv4/config/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のように、Clair 設定ファイルを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Clair の設定形式の詳細は、Clair 設定リファレンス を参照してください。

コンテナーイメージを使用して Clair を起動し、作成したファイルから設定にマウントします。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記複数の Clair コンテナーを実行することもできますが、単一のコンテナーを超えるデプロイシナリオでは、Kubernetes や OpenShift Container Platform などのコンテナーオーケストレーターを使用することが強く推奨されます。

6.3. OpenShift Container Platform の Clair

OpenShift Container Platform 上の Red Hat Quay デプロイメントで Clair v4 (Clair) をセットアップするには、Red Hat Quay Operator を使用することが推奨されます。デフォルトでは、Red Hat Quay Operator は、Clair デプロイメントを Red Hat Quay デプロイメントとともにインストールまたはアップグレードし、Clair を自動的に設定します。

6.4. Clair のテスト

以下の手順を使用して、スタンドアロンの Red Hat Quay デプロイメントまたは OpenShift Container Platform Operator ベースのデプロイメントで Clair をテストします。

前提条件

- Clair コンテナーイメージをデプロイしている。

手順

次のコマンドを入力して、サンプルイメージをプルします。

podman pull ubuntu:20.04

$ podman pull ubuntu:20.04Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、レジストリーにイメージをタグ付けします。

sudo podman tag docker.io/library/ubuntu:20.04 <quay-server.example.com>/<user-name>/ubuntu:20.04

$ sudo podman tag docker.io/library/ubuntu:20.04 <quay-server.example.com>/<user-name>/ubuntu:20.04Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを入力して、イメージを Red Hat Quay レジストリーにプッシュします。

sudo podman push --tls-verify=false quay-server.example.com/quayadmin/ubuntu:20.04

$ sudo podman push --tls-verify=false quay-server.example.com/quayadmin/ubuntu:20.04Copy to Clipboard Copied! Toggle word wrap Toggle overflow - UI から Red Hat Quay デプロイメントにログインします。

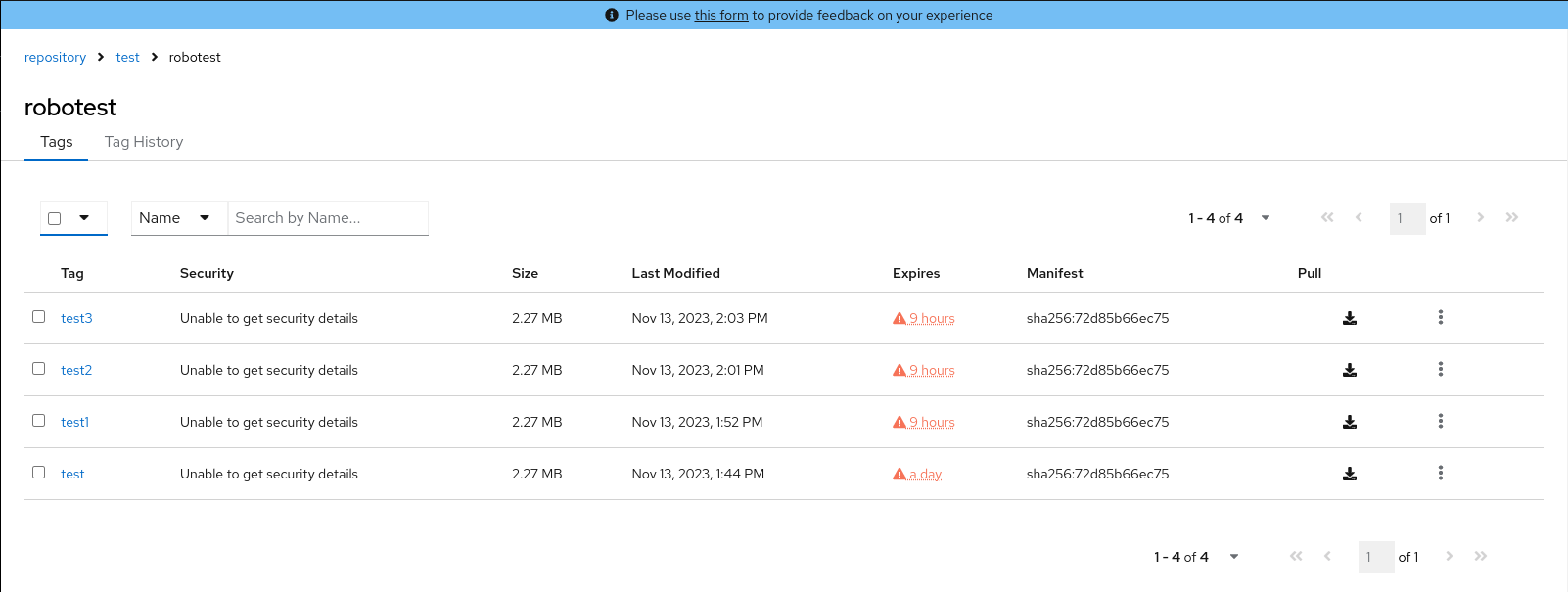

- リポジトリー名 (quayadmin/ubuntu など) をクリックします。

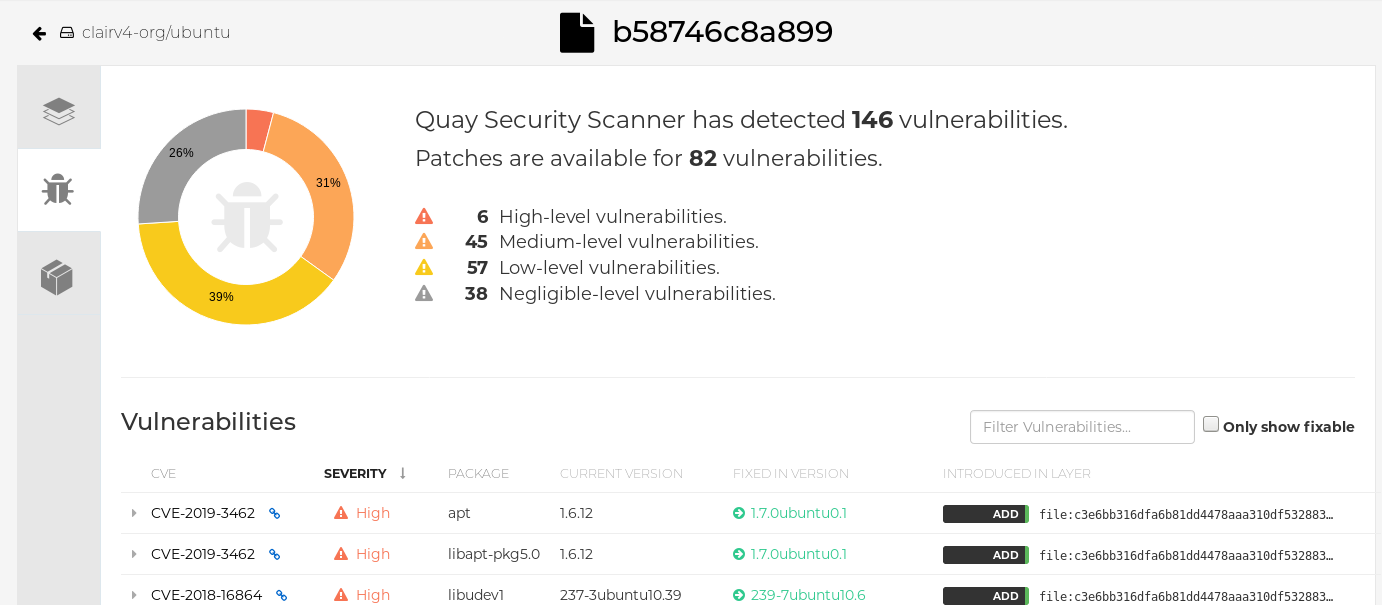

ナビゲーションウィンドウで、Tags をクリックします。

レポートの概要

イメージレポート (例: 45 medium) をクリックして、より詳細なレポートを表示します。

レポートの詳細

注記

注記場合によっては、Clair はイメージに関する重複レポートを表示します (例:

ubi8/nodejs-12またはubi8/nodejs-16)。これは、同じ名前の脆弱性が異なるパッケージに存在するために発生します。この動作は Clair 脆弱性レポートで予期されており、バグとしては扱われません。

第7章 リポジトリーのミラーリング

7.1. リポジトリーのミラーリング

Red Hat Quay リポジトリーミラーリングを使用すると、外部コンテナーレジストリー (または別のローカルレジストリー) から Red Hat Quay クラスターにイメージをミラーリングできます。リポジトリーミラーリングを使用すると、リポジトリー名とタグに基づいてイメージを Red Hat Quay に同期できます。

リポジトリーのミラーリングが有効になっている Red Hat Quay クラスターから、以下を実行できます。

- 外部のレジストリーからミラーリングするリポジトリーを選択する

- 外部レジストリーにアクセスするための認証情報を追加する

- 同期する特定のコンテナーイメージリポジトリー名とタグを特定する

- リポジトリーが同期される間隔を設定する

- 同期の現在の状態を確認する

ミラーリング機能を使用するには、次のアクションを実行する必要があります。

- Red Hat Quay 設定ファイルでリポジトリーのミラーリングを有効にする

- リポジトリーミラーリングワーカーを実行する

- ミラーリングされたリポジトリーを作成する

すべてのリポジトリーのミラーリング設定は、設定ツール UI または Red Hat Quay API を使用して実行できます。

7.2. Geo レプリケーションと比較したリポジトリーミラーリング

Red Hat Quay の Geo レプリケーションは、データベースが共有されている間に、2 つ以上の異なるストレージバックエンド間でイメージストレージのバックエンドデータ全体をミラーリングします (たとえば、2 つの異なる Blob ストレージエンドポイントを持つ 1 つの Red Hat Quay レジストリー)。Geo レプリケーションの主なユースケースには、次のようなものがあります。

- 地理的に分散する設定向けのバイナリー Blob へのアクセス速度を上げる

- イメージのコンテンツがリージョン全体で同じであることを保証する

リポジトリーのミラーリングは、選択されたリポジトリー (またはリポジトリーのサブセット) をあるレジストリーから別のレジストリーに同期します。レジストリーは固有であり、各レジストリーには個別のデータベースおよび個別のイメージストレージがあります。

ミラーリングの主な使用例は次のとおりです。

- 異なるデータセンターまたはリージョンでの独立したレジストリーのデプロイメント。ここでは、全コンテンツの特定サブセットがデータセンター/リージョン間で共有されることになっています。

- 外部レジストリーからローカル Red Hat Quay デプロイメントへの選択された (許可リスト化された) アップストリームリポジトリーの自動同期またはミラーリング。

リポジトリーのミラーリングと Geo レプリケーションを同時に使用できます。

| 機能と性能 | Geo レプリケーション | リポジトリーのミラーリング |

|---|---|---|

| 設計されている機能 | グローバルに共有されるレジストリー | 独立した異なるレジストレーション |

| レプリケーションまたはミラーリングがまだ完了していない場合はどうなるか? | リモートコピーを使用する (遅くなります) | イメージが表示されない |

| 両地域のすべてのストレージバックエンドへのアクセスが必要か? | はい (すべての Red Hat Quay ノード) | いいえ (個別のストレージ) |

| ユーザーは両方のサイトのイメージを同じリポジトリーにプッシュできるか? | はい | いいえ |

| すべてのレジストリーの内容と設定がすべての地域で同一であるかどうか (共有データベース)? | はい | いいえ |

| ユーザーはミラーリングする個別の namespace またはリポジトリーを選択できるか? | いいえ | はい |

| ユーザーは同期ルールにフィルターを適用できるか? | いいえ | はい |

| 各地域で許可されている個々の/異なるロールベースのアクセス制御設定があるか? | いいえ | はい |

7.3. リポジトリーミラーリングの使用

次のリストは、Red Hat Quay リポジトリーのミラーリングの機能と制限を示しています。

- リポジトリーのミラーリングでは、リポジトリー全体をミラーリングしたり、同期するイメージを選択的に制限したりできます。フィルターは、コンマ区切りのタグのリスト、タグの範囲、または Unix シェルスタイルのワイルドカードを使用してタグを識別するその他の手段に基づくことができます。詳細は、ワイルドカード のドキュメントを参照してください。

- ミラーリングされたリポジトリーとして設定した場合は、そのリポジトリーに他のイメージを手動で追加できません。

- ミラーリングされたリポジトリーは設定したリポジトリーとタグに基づいているため、リポジトリーとタグのペアで表されるコンテンツのみが保持されます。たとえば、タグを変更してリポジトリー内の一部のイメージが一致しなくなると、それらのイメージは削除されます。

- 指定されたロボットだけが、ミラーリングされたリポジトリーにイメージをプッシュすることができ、リポジトリーに設定されたロールベースのアクセスコントロール権限に優先します。

- ミラーリングは、障害時にロールバックする、または ベストエフォートベースで実行するように設定できます。

- ミラーリングされたリポジトリーでは、read 権限を持つユーザーはリポジトリーからイメージをプルできますが、イメージをリポジトリーにプッシュすることはできません。

- ミラーリングされたリポジトリーの設定の変更は、Red Hat Quay ユーザーインターフェイスで、作成したミラーリングされたリポジトリーの Repositories → Mirrors タブを使用して実行できます。

- イメージは一定の間隔で同期されますが、必要に応じて同期することもできます。

7.4. リポジトリーミラーリングの有効化

デフォルトでは、FEATURE_REPO_MIRROR は False に設定されています。ミラーリングを有効にするには、config.yaml ファイルで FEATURE_REPO_MIRROR: true を設定する必要があります。

手順

config.yamlファイルでFEATURE_REPO_MIRROR: trueを設定します。以下に例を示します。# ... FEATURE_REPO_MIRROR: true # ...

# ... FEATURE_REPO_MIRROR: true # ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Quay レジストリーを再起動します。

7.5. 設定フィールドのミラーリング

Red Hat Quay のミラーリングにより、リポジトリーとアップストリームソースの自動同期が可能になります。この機能は、リモートコンテナーイメージのローカルミラーを維持したり、非接続環境での可用性を確保したり、キャッシュを通じてパフォーマンスを向上させたりするのに役立ちます。

関連情報

| フィールド | 型 | 説明 |

|---|---|---|

| FEATURE_REPO_MIRROR | Boolean |

リポジトリーミラーリングを有効または無効にする |

| REPO_MIRROR_INTERVAL | 数値 |

次にリポジトリーミラー候補をチェックするまでの秒数。 |

| REPO_MIRROR_SERVER_HOSTNAME | 文字列 |

|

| REPO_MIRROR_TLS_VERIFY | Boolean |

HTTPS を必要とし、ミラー時に Quay レジストリーの証明書を検証します。 |

| REPO_MIRROR_ROLLBACK | Boolean |

デフォルト: |

| SKOPEO_TIMEOUT_INTERVAL | Integer |

タイムアウトするまでにミラーリングジョブが実行される秒数。 |

ミラーリング設定の YAML サンプル

7.6. ミラーリングワーカー

次の手順を使用して、リポジトリーミラーリングワーカーを開始します。

手順

/root/ca.crt証明書を使用して TLS 通信を設定していない場合は、次のコマンドを入力し、repomirrorオプションを指定して、QuayPod を開始します。sudo podman run -d --name mirroring-worker \ -v $QUAY/config:/conf/stack:Z \ registry.redhat.io/quay/quay-rhel8:v3.15.1 repomirror

$ sudo podman run -d --name mirroring-worker \ -v $QUAY/config:/conf/stack:Z \ registry.redhat.io/quay/quay-rhel8:v3.15.1 repomirrorCopy to Clipboard Copied! Toggle word wrap Toggle overflow /root/ca.crt証明書を使用して TLS 通信を設定している場合は、次のコマンドを入力して、リポジトリーミラーリングワーカーを開始します。sudo podman run -d --name mirroring-worker \ -v $QUAY/config:/conf/stack:Z \ -v /root/ca.crt:/etc/pki/ca-trust/source/anchors/ca.crt:Z \ registry.redhat.io/quay/quay-rhel8:v3.15.1 repomirror

$ sudo podman run -d --name mirroring-worker \ -v $QUAY/config:/conf/stack:Z \ -v /root/ca.crt:/etc/pki/ca-trust/source/anchors/ca.crt:Z \ registry.redhat.io/quay/quay-rhel8:v3.15.1 repomirrorCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.7. ミラーリングされたリポジトリーの作成

外部コンテナーレジストリーからリポジトリーをミラーリングする場合は、新しいプライベートリポジトリーを作成する必要があります。通常、ターゲットリポジトリーと同じ名前が使用されます (例: quay-rhel9)。

7.7.1. リポジトリーのミラーリングの設定

ミラーリングされたリポジトリーの設定を調整するには、次の手順を使用します。

前提条件

- Red Hat Quay 設定ファイルでリポジトリーミラーリングを有効にしている。

- ミラーリングワーカーをデプロイしている。

手順

- レジストリーの リポジトリー ページに移動し、リポジトリーの名前 (例: test-mirror) をクリックします。

- [設定] → [リポジトリーの状態] をクリックします。

- ミラー をクリックします。

- [ミラーリング] タブをクリックし、タグ、スケジュール、アクセス情報とともに、外部レジストリーに接続するための詳細を入力します。

必要に応じて、以下のフィールドに詳細を入力します。

-

レジストリーの場所: ミラーリングする外部リポジトリー (例:

registry.redhat.io/quay/quay-rhel8)。 - タグ: 個々のタグまたはタグパターンのコンマ区切りのリストを入力します。(詳細は、タグパターン のセクションを参照してください。)

- Start Date: ミラーリングが開始する日付。現在の日時がデフォルトで使用されます。

- Sync Interval: デフォルトで 24 時間ごとの同期に設定されます。これは時間または日に基づいて変更できます。

-

Skopeo タイムアウト内部: デフォルトは

300秒 (5 分) です。タイムアウトの最大長さは43200秒 (12 時間) です。 - Robot User: 新しい robot アカウントを作成するか、既存の robot アカウントを選択してミラーリングを実行します。

- Username: ミラーリングするリポジトリーを保持する外部レジストリーにアクセスするためのユーザー名。

- Password: ユーザー名に関連付けられたパスワード。パスワードにはエスケープ文字 (\) を必要とする文字を使用できないことに注意してください。

-

レジストリーの場所: ミラーリングする外部リポジトリー (例:

詳細設定 セクションでは、次のオプションを使用して SSL/TLS とプロキシーを任意で設定できます。

- Verify TLS: ターゲットのリモートレジストリーと通信するときに HTTPS を要求し、証明書を検証する場合は、このオプションを選択します。

- Accept Unsigned Images: このオプションを選択すると、署名されていないイメージをミラーリングできます。

- HTTP Proxy: ターゲットのリモートレジストリーと通信するときに HTTPS を要求し、証明書を検証する場合は、このオプションを選択します。

- HTTPS PROXY: プロキシーサーバーが必要な場合は、リモートサイトにアクセスするために必要な HTTPS プロキシーサーバーを特定します。

- No Proxy: プロキシーを必要としない場所のリスト。

- すべての情報を入力したら、ミラーを有効にする をクリックします。

7.7.2. 今すぐ同期する

ミラーリング操作を開始するには、次の手順を使用します。

手順

- リポジトリーの ミラーリング タブに移動します。

- 今すぐ同期 ボタンを押します。

検証

- 利用可能なログを表示するには、[ログ] タブをクリックします。

- ミラーリングが完了すると、イメージが タグ タブに表示されます。

7.8. ミラーリングのイベント通知

リポジトリーミラーリングには、3 つの通知イベントがあります。

- リポジトリーミラーリングの開始

- リポジトリーのミラーリングの成功

- リポジトリーミラーリングの失敗

イベントは各リポジトリーの Settings タブ内で設定でき、電子メール、Slack、Quay UI、Webhook などの既存の通知方法がすべてサポートされています。

7.9. タグパターンのミラーリング

少なくとも 1 つのタグを入力する必要があります。次の表は、考えられるイメージタグのパターンを示しています。

7.9.1. パターン構文

| パターン | 説明 |

| * | すべての文字に一致。 |

| ? | 任意の単一文字に一致。 |

| [seq] | seq の任意の文字と一致。 |

| [!seq] | seq にない文字と一致。 |

7.9.2. タグのパターン例

| パターン例 | マッチの例 |

| v3* | v32、v3.1、v3.2、v3.2-4beta、v3.3 |

| v3.* | v3.1、v3.2、v3.2-4beta |

| v3.? | v3.1、v3.2、v3.3 |

| v3.[12] | v3.1、v3.2 |

| v3.[12]* | v3.1、v3.2、v3.2-4beta |

| v3.[!1]* | v3.2、v3.2-4beta、v3.3 |

7.10. ミラーリングされたリポジトリーの使用

ミラー化されたリポジトリーを作成したら、そのリポジトリーを操作する方法はいくつかあります。

リポジトリー ページからミラーリングされたリポジトリーを選択し、次のいずれかを実行します。

- リポジトリーの有効化/無効化: 左列の Mirroring ボタンを選択してから Enabled チェックボックスを切り替え、一時的にリポジトリーを有効または無効にします。

- ミラーログの確認: ミラーリングされたリポジトリーが正常に動作していることを確認するために、ミラーログを確認することができます。そのためには、左カラムの Usage Logs ボタンを選択します。以下に例を示します。

- 今すぐミラーを同期: リポジトリー内のイメージをすぐに同期するには、Sync Now ボタンを選択します。

- クレデンシャルの変更: ユーザー名とパスワードを変更するには、Credentials の行から DELETE を選択します。その後、なしを選択し、プロンプトが表示されたら、外部レジストリーにログインするために必要なユーザー名とパスワードを追加します。

- ミラーリングのキャンセル: ミラーリングを中止するには、CANCEL ボタンを選択します。これにより、現在のイメージはそのまま利用できますが、新しいイメージは同期されなくなります。

ロボットのパーミッション設定: Red Hat Quay のロボットアカウントは、外部のリポジトリーにアクセスするための認証情報を保持する名前付きのトークンです。ロボットに認証情報を割り当てることで、そのロボットは、同じ外部レジストリーにアクセスする必要のある複数のミラーリングされたリポジトリーで使用することができます。

組織 → ロボットアカウント に移動して、既存のロボットをリポジトリーに割り当てることができます。このページでは、次の情報を確認できます。

- そのロボットにどのリポジトリーが割り当てられているかを確認します。

-

PERMISSION フィールドからそのロボットに

読み取り、書き込み、または管理者特権を割り当てます。

- ロボットの認証情報の変更: ロボットは、Kubernetes シークレット、Docker ログイン情報、Podman ログイン情報などの認証情報を保持できます。ロボットの認証情報を変更するには、Robot Accounts ウィンドウのロボットのアカウント行にある Options ギアを選択し、View Credentials を選択します。ロボットがアクセスする必要のある外部リポジトリーの適切な認証情報を追加します。

- 一般設定の確認と変更: ミラーリングされたリポジトリーのページの左カラムから設定ボタン (歯車のアイコン) を選択します。表示されるページでは、ミラーリングされたリポジトリーに関連する設定を変更できます。特に、ユーザーやロボットのパーミッションを変更して、どのユーザーやロボットがレポジトリーを読み書きできるかを正確に指定することができます。

7.11. リポジトリーのミラーリングの推奨事項

リポジトリーミラーリングのベストプラクティスには次のようなものがあります。

- リポジトリーミラーリング Pod は任意のノードで実行できます。これは、Red Hat Quay がすでに実行されているノードでミラーリングを実行できることを意味します。

- リポジトリーのミラーリングは、データベースでスケジュールされ、一括して実行されます。その結果、リポジトリーワーカーは各リポジトリーミラー設定ファイルをチェックし、次の同期が必要なタイミングを読み取ります。ミラーワーカーが増えると、より多くのリポジトリーを同時にミラーリングできるようになります。たとえば、10 個のミラーワーカーを実行すると、ユーザーは 10 個のミラーリング Operator を並行して実行できることになります。ミラー設定が 10 個あるワーカーが 2 つしかない場合に、実行できる Operator は 2 つのみです。

ミラーリング Pod の最適な数は、次の条件によって異なります。

- ミラーリングされるリポジトリーの合計数

- リポジトリー内のイメージやタグの数と変更の頻度

並列バッチ処理

たとえば、タグが 100 個あるリポジトリーをミラーリングしている場合に、このミラーは 1 つのワーカーで完了されます。ユーザーは、並行してミラーリングするリポジトリーの数を検討し、それに基づいてワーカーの数を決定する必要があります。

同じリポジトリー内の複数のタグを並行してミラーリングすることはできません。

第8章 IPv6 およびデュアルスタックデプロイメント

スタンドアロンの Red Hat Quay デプロイメントは、Telco や Edge 環境など、IPv6 のみをサポートする場所で提供できるようになりました。デュアルスタックネットワーキングのサポートも提供されるため、Red Hat Quay デプロイメントは IPv4 と IPv6 を同時にリッスンできます。

既知の制限のリストは、IPv6 の制限 を参照してください。

8.1. IPv6 プロトコルファミリーの有効化

以下の手順を使用して、スタンドアロンの Red Hat Quay デプロイメントで IPv6 サポートを有効にします。

前提条件

- Red Hat Quay を 3.8 に更新している。

- ホストとコンテナーソフトウェアプラットフォーム (Docker、Podman) を、IPv6 をサポートするように設定している。

手順

デプロイメントの

config.yamlファイルにFEATURE_LISTEN_IP_VERSIONパラメーターを追加し、IPv6に設定します。次に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Quay デプロイメントを起動または再起動します。

次のコマンドを入力して、デプロイが IPv6 をリッスンしていることを確認します。

curl <quay_endpoint>/health/instance {"data":{"services":{"auth":true,"database":true,"disk_space":true,"registry_gunicorn":true,"service_key":true,"web_gunicorn":true}},"status_code":200}$ curl <quay_endpoint>/health/instance {"data":{"services":{"auth":true,"database":true,"disk_space":true,"registry_gunicorn":true,"service_key":true,"web_gunicorn":true}},"status_code":200}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

デプロイメントの config.yaml で IPv6 を有効にすると、環境が IPv6 を使用するように設定されており、ipv6 制限 (現在の制限) によって妨げられていない限り、すべての Red Hat Quay 機能を通常どおり使用できます。

環境が IPv4 に設定されていても、FEATURE_LISTEN_IP_VERSION 設定フィールドが IPv6 に設定されていると、Red Hat Quay はデプロイに失敗します。

8.2. デュアルスタックプロトコルファミリーの有効化

以下の手順を使用して、スタンドアロンの Red Hat Quay デプロイメントでデュアルスタック (IPv4 および IPv6) サポートを有効にします。

前提条件

- Red Hat Quay を 3.8 に更新している。

- ホストとコンテナーソフトウェアプラットフォーム (Docker、Podman) を、IPv6 をサポートするように設定している。

手順

デプロイメントの

config.yamlファイルで、FEATURE_LISTEN_IP_VERSIONパラメーターを追加し、dual-stackに設定します。次に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Quay デプロイメントを起動または再起動します。

次のコマンドを入力して、デプロイメントが両方のチャネルをリッスンしていることを確認します。

IPv4 の場合、次のコマンドを入力します。

curl --ipv4 <quay_endpoint> {"data":{"services":{"auth":true,"database":true,"disk_space":true,"registry_gunicorn":true,"service_key":true,"web_gunicorn":true}},"status_code":200}$ curl --ipv4 <quay_endpoint> {"data":{"services":{"auth":true,"database":true,"disk_space":true,"registry_gunicorn":true,"service_key":true,"web_gunicorn":true}},"status_code":200}Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv6 の場合、次のコマンドを入力します。

curl --ipv6 <quay_endpoint> {"data":{"services":{"auth":true,"database":true,"disk_space":true,"registry_gunicorn":true,"service_key":true,"web_gunicorn":true}},"status_code":200}$ curl --ipv6 <quay_endpoint> {"data":{"services":{"auth":true,"database":true,"disk_space":true,"registry_gunicorn":true,"service_key":true,"web_gunicorn":true}},"status_code":200}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

デプロイメントの config.yaml でデュアルスタックを有効にすると、環境がデュアルスタック用に設定されている限り、Red Hat Quay のすべての機能を通常どおり使用できます。

8.3. IPv6 とデュアルスタックの制限:

現在、一般的な Azure Blob Storage 設定を使用して Red Hat Quay デプロイメントを設定しようとしても、IPv6 シングルスタック環境では機能しません。Azure Blob Storage のエンドポイントは IPv6 をサポートしていないため、この問題に対する回避策はありません。

詳細は、PROJQUAY-4433 を参照してください。

現在、Amazon S3 CloudFront を使用して Red Hat Quay デプロイメントを設定しようとしても、IPv6 シングルスタック環境では機能しません。Amazon S3 CloudFront のエンドポイントは IPv6 をサポートしていないため、この問題に対する回避策はありません。

詳細は、PROJQUAY-4470 を参照してください。

第9章 Red Hat Quay の LDAP 認証設定

LDAP (Lightweight Directory Access Protocol) は、IP ネットワークで分散ディレクトリー情報サービスにアクセスし、これを維持するために使用するオープンな、ベンダーに依存しない業界標準のアプリケーションプロトコルです。Red Hat Quay は ID プロバイダーとして LDAP の使用をサポートしています。

9.1. LDAP を有効にする際の考慮事項

Red Hat Quay デプロイメントで LDAP を有効にする前に、以下の点を考慮する必要があります。

既存の Red Hat Quay デプロイメント

ユーザーがすでに設定されている既存の Red Hat Quay デプロイメントで LDAP を有効にすると、ユーザー名との競合が発生する可能性があります。たとえば、1 人のユーザー alice は、LDAP を有効にする前に Red Hat Quay で手動で作成されました。ユーザー名 alice が LDAP ディレクトリーにも存在する場合、alice が LDAP を使用して初めてログインするときに、Red Hat Quay は新しいユーザー alice-1 を自動的に作成します。次に、Red Hat Quay は LDAP 認証情報を alice アカウントに自動的にマッピングします。一貫性の理由から、これは Red Hat Quay デプロイメントにとっては誤りである可能性があります。LDAP を有効にする前に、競合する可能性のあるローカルアカウント名を Red Hat Quay から削除することを推奨します。

手動ユーザーの作成と LDAP 認証

Red Hat Quay が LDAP 用に設定されている場合、設定オプション FEATURE_USER_CREATION が True に設定されていると、最初のログイン時に LDAP 認証ユーザーが Red Hat Quay のデータベースに自動的に作成されます。このオプションを False に設定すると、LDAP ユーザーの自動ユーザー作成が失敗し、ユーザーはログインできなくなります。このシナリオでは、スーパーユーザーが最初に必要なユーザーアカウントを作成する必要があります。逆に、FEATURE_USER_CREATION が True に設定されている場合、LDAP に同等のユーザーがいる場合でも、ユーザーは Red Hat Quay ログイン画面からアカウントを作成できることになります。

9.2. Red Hat Quay 用の LDAP の設定

config.yaml ファイルを直接更新してデプロイメントを再起動することで、Red Hat Quay の LDAP を設定できます。Red Hat Quay の LDAP を設定する場合は、次の手順を参考として使用してください。

config.yamlファイルを直接更新して、次の関連情報を含めます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 必須。

LDAPに設定する必要があります。 - 2

- 必須。LDAP 認証の管理 DN。

- 3

- 必須。LDAP 認証の管理パスワード。

- 4

- 必須。LDAP 認証に SSL/TLS の安全でないフォールバックを許可するかどうか。

- 5

- 必須。LDAP 認証のベース DN。

- 6

- 必須。LDAP 認証のメール属性。

- 7

- 必須。LDAP 認証の UID 属性。

- 8

- 必須。LDAP URI。

- 9

- 必須。LDAP 認証のユーザーフィルター。

- 10

- 必須。LDAP 認証のユーザー RDN。

- 11

- オプション: ユーザーオブジェクトが存在する組織単位が複数ある場合の Secondary User Relative DN。

- 必要な LDAP フィールドをすべて追加したら、変更を保存して Red Hat Quay デプロイメントを再起動します。

9.3. LDAP_RESTRICTED_USER_FILTER 設定フィールドの有効化

LDAP_RESTRICTED_USER_FILTER 設定フィールドは、LDAP_USER_FILTER 設定フィールドのサブセットです。このオプションを設定すると、Red Hat Quay が認証プロバイダーとして LDAP を使用する場合、Red Hat Quay 管理者は LDAP ユーザーを制限付きユーザーとして設定できるようになります。

以下の手順を使用して、Red Hat Quay デプロイメントで LDAP 制限付きユーザーを有効にします。

前提条件

- Red Hat Quay デプロイメントは認証プロバイダーとして LDAP を使用している。

-

config.yamlファイルでLDAP_USER_FILTERフィールドを設定している。

手順

デプロイメントの

config.yamlファイルで、LDAP_RESTRICTED_USER_FILTERパラメーターを追加し、制限されたユーザーのグループ (たとえばmembers) を指定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Quay デプロイメントを起動または再起動します。

LDAP_RESTRICTED_USER_FILTER 機能を有効にすると、LDAP Red Hat Quay ユーザーは、コンテンツの読み取りと書き込み、および組織の作成が制限されます。

9.4. LDAP_SUPERUSER_FILTER 設定フィールドの有効化

LDAP_SUPERUSER_FILTER フィールドを設定すると、Red Hat Quay が LDAP を認証プロバイダーとして使用する場合、Red Hat Quay 管理者は LDAP (Lightweight Directory Access Protocol) ユーザーをスーパーユーザーとして設定できます。

以下の手順を使用して、Red Hat Quay デプロイメントで LDAP スーパーユーザーを有効にします。

前提条件

- Red Hat Quay デプロイメントは認証プロバイダーとして LDAP を使用している。

-

config.yamlファイルでLDAP_USER_FILTERフィールドを設定ている。

手順

デプロイメントの

config.yamlファイルで、LDAP_SUPERUSER_FILTERパラメーターを追加し、スーパーユーザーとして設定するユーザーのグループ (rootなど) を追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定されたユーザーをスーパーユーザーとして設定します。

- Red Hat Quay デプロイメントを起動または再起動します。

LDAP_SUPERUSER_FILTER 機能を有効にすると、LDAP Red Hat Quay ユーザーにスーパーユーザー権限が付与されます。スーパーユーザーは次のオプションを使用できます。

- ユーザーの管理

- 組織の管理

- サービスキーの管理

- 変更ログの閲覧

- 使用状況ログのクエリー

- グローバルに表示されるユーザーメッセージの作成

9.5. 一般的な LDAP 設定の問題

設定が無効な場合、次のエラーが返される場合があります。

- Invalid credentials。このエラーが発生した場合は、管理者 DN または管理者 DN パスワードの値が正しくありません。正確な管理者 DN とパスワードの値を指定していることを確認してください。

*スーパーユーザー %USERNAME% の検証に失敗しました。このエラーは次の理由で返されます。

- ユーザー名が見つかりませんでした。

- ユーザーはリモート認証システムに存在しません。

- LDAP 認証が正しく設定されていません。

現在ログインしているユーザーが見つかりません。Red Hat Quay の LDAP を設定する場合、Administrator DN フィールドに指定されたユーザー名とパスワードを使用して LDAP 接続が正常に確立される場合があります。ただし、UID Attribute または Mail Attribute フィールドを使用して、指定された User Relative DN パス内で現在ログインしているユーザーが見つからない場合は、通常、次の 2 つの理由が考えられます。

- 現在ログインしているユーザーは、User Relative DN パスに存在しません。

Administrator DN には、指定された LDAP パスを検索または読み取る権限がありません。

この問題を解決するには、ログインしているユーザーが User Relative DN パスに含まれていることを確認するか、Administrator DN アカウントに正しいアクセス許可を与えます。

9.6. LDAP 設定フィールド

LDAP 設定フィールドの完全なリストは、LDAP 設定フィールド を参照してください。

第10章 Red Hat Quay の OIDC の設定

Red Hat Quay 用に OpenID Connect (OIDC) を設定すると、デプロイメントにメリットがいくつかあります。たとえば、OIDC を使用すると、ユーザーは Red Hat Single Sign-On、Google、Github、Microsoft などの OIDC プロバイダーからの既存の認証情報を使用して Red Hat Quay に対して認証できるようになります。OIDC のその他の利点には、一元的なユーザー管理、より強固なキュリティー、Single Sign-On (SSO) などがあります。全体として、OIDC 設定はユーザーの認証と管理を簡素化し、セキュリティーを強化して、Red Hat Quay ユーザーにシームレスなユーザーエクスペリエンスを提供します。

以下の手順では、Red Hat Quay のスタンドアロンデプロイメントで Microsoft Entra ID を設定する方法と、Red Hat Quay の Operator ベースのデプロイメントで Red Hat Single Sign-On を設定する方法を示します。これらの手順は、デプロイメントタイプに応じて交換可能です。

これらの手順に従うことで、使用する認証プロバイダーに関係なく、任意の OIDC プロバイダーを Red Hat Quay に追加できるようになります。

10.1. Red Hat Quay のスタンドアロンデプロイメントでの Microsoft Entra ID OIDC の設定

Microsoft Entra ID 認証を Red Hat Quay と統合することで、組織は Microsoft Entra ID が提供する集約ユーザー管理およびセキュリティー機能を活用できるようになります。一部の機能には、Microsoft Entra ID のロールと権限に基づいて Red Hat Quay リポジトリーへのユーザーアクセスを管理する機能や、Microsoft Entra ID によって提供される多要素認証やその他のセキュリティー機能を有効にする機能が含まれます。

Red Hat Quay の Azure Active Directory (Microsoft Entra ID) 認証により、ユーザーは Microsoft Entra ID 認証情報を使用して Red Hat Quay を認証し、アクセスできるようになります。

以下の手順を使用して、Red Hat Quay config.yaml ファイルを直接更新して Microsoft Entra ID を設定します。

- 次の手順を使用すると、追加されている認証プロバイダーに関係なく、任意の ODIC プロバイダーを Red Hat Quay に追加できます。

-

システムでファイアウォールが使用されている場合、またはプロキシーが有効になっている場合は、作成される Oauth アプリケーションごとにすべての Azure API エンドポイントをホワイトリストに登録する必要があります。それ以外の場合は、次のエラーが返されます。

x509: certificate signed by unknown authority

次のリファレンスを使用して任意の OIDC プロバイダーの認証情報で

config.yamlファイルを更新します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- OIDC 設定を保持する親キー。この例では、使用される親キーは

AZURE_LOGIN_CONFIGです。ただし、文字列AZUREは、特定のニーズに基づいて任意の文字列 (たとえば、ABC123) に置き換えることができます。ただし、次の文字列は受け入れられません:GOOGLE、GITHUB。これらの文字列は、それぞれの ID プラットフォーム用に予約されており、使用するプラットフォームに応じて特定のconfig.yamlエントリーが必要です。 - 2

- 認証プロバイダーに再登録されるアプリケーションのクライアント ID。

- 3

- 認証プロバイダーに登録されているアプリケーションのクライアントシークレット。

- 4

- 認証に使用される OIDC サーバーのアドレス。この例では、issuer 識別子として

sts.windows.netを使用する必要があります。https://login.microsoftonline.comを使用すると、次のエラーが発生します。Could not create provider for AzureAD.Error: oidc: issuer did not match the issuer returned by provider, expected "https://login.microsoftonline.com/73f2e714-xxxx-xxxx-xxxx-dffe1df8a5d5" got "https://sts.windows.net/73f2e714-xxxx-xxxx-xxxx-dffe1df8a5d5/". - 5

- 認証されているサービスの名前。

- 6

- ユーザーの電子メールアドレスを確認するために使用されるクレームの名前。

Microsoft Entra ID を適切に設定すると、次の形式の 3 つのリダイレクトが行われます。

-

https://QUAY_HOSTNAME/oauth2/<name_of_service>/callback -

https://QUAY_HOSTNAME/oauth2/<name_of_service>/callback/attach -

https://QUAY_HOSTNAME/oauth2/<name_of_service>/callback/cli

-

- Red Hat Quay デプロイメントを再起動します。

10.2. Red Hat Quay の Red Hat Single Sign-On の設定

Keycloak プロジェクトに基づいた Red Hat Single Sign-On (RH-SSO) は、Red Hat が提供するオープンソースのアイデンティティーおよびアクセス管理 (IAM) ソリューションです。RH-SSO を使用すると、組織はユーザー ID を管理し、アプリケーションを保護して、システムとアプリケーション全体にアクセス制御ポリシーを適用できます。また、統合された認証および認可フレームワークも提供します。これにより、ユーザーは一度ログインすることで、再認証することなく複数のアプリケーションやリソースにアクセスできるようになります。詳細は、Red Hat Single Sign-On を参照してください。

Red Hat Quay で Red Hat Single Sign-On を設定すると、Red Hat Quay と OpenShift Container Platform などの他のアプリケーションプラットフォームの間にシームレスな認証インテグレーションを作成できます。

10.2.1. Red Hat Quay Operator で使用するための Red Hat Single Sign-On Operator の設定

以下の手順を使用して、OpenShift Container Platform で Red Hat Quay Operator の Red Hat Single Sign-On を設定します。

前提条件

- Red Hat Single Sign-On Operator が設定されている。詳細は、Red Hat Single Sign-On Operator を参照してください。

- Red Hat Single Sign-On および OpenShift Container Platform デプロイメントで Red Hat Quay に SSL/TLS が設定されている。

- 単一の認証局 (CA) を生成し、それを Red Hat Single Sign-On Operator と Red Hat Quay 設定にアップロードしている。

手順

Red Hat Single Sign-On 管理コンソール に移動します。

- OpenShift Container Platform Web コンソール で、Network → Route に移動します。

- ドロップダウンリストから Red Hat Single Sign-On プロジェクトを選択します。

- Routes テーブルで Red Hat Single Sign-On 管理コンソール を見つけます。

- Red Hat Quay の設定に使用するレルムを選択します。

- ナビゲーションパネルの Configure セクションで Clients をクリックし、Create ボタンをクリックして Red Hat Quay の新しい OIDC を追加します。

以下の情報を入力します。

-

Client ID:

quay-enterprise -

Client Protocol:

openid-connect -

Root URL:

https://<quay_endpoint>/

-

Client ID:

- Save をクリックします。これにより、Clients 設定パネルにリダイレクトされます。

- Access Type に移動し、Confidential を選択します。

Valid Redirect URI に移動します。3 つのリダイレクト URI を指定する必要があります。値は、Red Hat Quay レジストリーの完全修飾ドメイン名に

/oauth2/redhatsso/callbackを付加したものである必要があります。以下に例を示します。-

https://<quay_endpoint>/oauth2/redhatsso/callback -

https://<quay_endpoint>/oauth2/redhatsso/callback/attach -

https://<quay_endpoint>/oauth2/redhatsso/callback/cli

-

- Save をクリックして、新しい Credentials 設定に移動します。

- Secret の値をコピーします。

10.2.1.1. Red Hat Single Sign-On を使用するための Red Hat Quay Operator の設定

Red Hat Quay Operator で Red Hat Single Sign-On を設定するには、次の手順を使用します。

前提条件

- Red Hat Single Sign-On Operator が設定されている。詳細は、Red Hat Single Sign-On Operator を参照してください。

- Red Hat Single Sign-On および OpenShift Container Platform デプロイメントで Red Hat Quay に SSL/TLS が設定されている。

- 単一の認証局 (CA) を生成し、それを Red Hat Single Sign-On Operator と Red Hat Quay 設定にアップロードしている。

手順

-

Operator → Installed Operators → Red Hat Quay → Quay Registry → Config Bundle Secret に移動して、Red Hat Quay

config.yamlファイルを編集します。次に、Actions → Edit Secret をクリックします。または、config.yamlファイルをローカルに更新することもできます。 以下の情報を OpenShift Container Platform

config.yamlファイルの Red Hat Quay に追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- OIDC 設定を保持する親キー。この例では、使用される親キーは

AZURE_LOGIN_CONFIGです。ただし、文字列AZUREは、特定のニーズに基づいて任意の文字列 (たとえば、ABC123) に置き換えることができます。ただし、次の文字列は受け入れられません:GOOGLE、GITHUB。これらの文字列は、それぞれの ID プラットフォーム用に予約されており、使用するプラットフォームに応じて特定のconfig.yamlエントリーが必要です。 - 2

- 認証プロバイダーで再登録されるアプリケーションのクライアント ID (例:

quay-enterprise)。 - 3

quay-enterpriseOIDC クライアント設定の Credentials タブのクライアントシークレット。- 4

- Red Hat Single Sign-On インスタンスの完全修飾ドメイン名 (FQDN) に

/auth/realms/とレルム名が追加されます。最後にスラッシュを含める必要があります (例:https://sso-redhat.example.com//auth/realms/<keycloak_realm_name>/)。 - 5

- Red Hat Quay ログインページに表示される名前 (例:

Red hat Single Sign On)。 - 6

- ログイン画面のアイコンを変更します。例:

/static/img/RedHat.svg. - 7

- ユーザーの電子メールアドレスを確認するために使用されるクレームの名前。

- 8

- ユーザーの電子メールアドレスを確認するために使用されるクレームの名前。

- 9

- ログインフローの実行時に OIDC プロバイダーに送信するスコープ (

openidなど)。

- Red Hat Single Sign-On を有効にして、OpenShift Container Platform デプロイメントで Red Hat Quay を再起動します。

10.3. Red Hat Quay OIDC デプロイメントのチーム同期

管理者は、グループまたはチームの同期をサポートする OpenID Connect (OIDC) アイデンティティープロバイダーを活用して、Red Hat Quay のユーザーセットにリポジトリー権限を適用できます。これにより、管理者は Red Hat Quay と OIDC グループ間でグループ定義を手動で作成して同期する必要がなくなります。

10.3.1. Red Hat Quay OIDC デプロイメントの同期の有効化

Red Hat Quay デプロイメントで OIDC オーセンティケーターを使用する場合、チーム同期を有効にするには、次の手順に従います。

次の手順では、特定の OIDC プロバイダーは使用されません。代わりに、OIDC プロバイダーおよび Red Hat Quay 間のチーム同期をどのように使用すると最適かを概説します。任意の OIDC プロバイダーを使用してチーム同期を有効にすることができますが、設定はプロバイダーによって異なる場合があります。

手順

次の情報を使用して

config.yamlファイルを更新します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 必須。この Red Hat Quay インスタンスの登録済み OIDC クライアント ID。

- 2

- 必須。この Red Hat Quay インスタンスの登録済み OIDC クライアントシークレット。

- 3

- 必須。認証に使用される OIDC サーバーのアドレス。この URL は、

<OIDC_SERVER>/.well-known/openid-configurationへのGETリクエストがプロバイダーの設定情報を返すような URL である必要があります。この設定情報は、依存当事者 (RP) が OpenID Connect プロバイダーと安全にやり取りし、認証および承認プロセスに必要な詳細を取得するために不可欠です。 - 4

- 必須。認証されているサービスの名前。

- 5

- 必須。ユーザーのグループメンバーシップに関する情報を保持する OIDC トークンペイロード内のキー名。このフィールドにより、認証システムは OIDC トークンからグループメンバーシップ情報を抽出し、Red Hat Quay で使用できるようになります。

- 6

- 必須。Red Hat Quay が OIDC プロバイダーとの通信に使用するスコープを追加します。

'openid'を含める必要があります。追加のスコープはオプションです。 - 7

/userinfoエンドポイントを許可するか無効にするかを指定します。Azure Entra ID を使用する場合は、このフィールドをTrueに設定します。デフォルトはFalseです。- 8

- 必須。認証エンジンのバッキンググループからチームメンバーシップを同期できるようにするかどうか。

- 9

- オプション: 有効にすると、スーパーユーザー以外のユーザーもチームの同期を設定できます。

- Red Hat Quay レジストリーを再起動します。

10.3.2. チーム同期のための Red Hat Quay デプロイメントの設定

- OIDC プロバイダー経由で Red Hat Quay レジストリーにログインします。

- Red Hat Quay v2 UI ダッシュボードで、Create Organization をクリックします。

-

組織名を入力します (例:

test-org)。 - 組織の名前をクリックします。

- ナビゲーションウィンドウで、Teams and membership をクリックします。

-

Create new team をクリックし、

testteamなどの名前を入力します。 Create team ポップアップで、以下を実行します。

- オプション: このチームをリポジトリーに追加します。

-

ユーザーのアカウント名を入力して、チームメンバー (例:

user1) を追加します。 - このチームにロボットアカウントを追加します。このページでは、ロボットアカウントを作成するオプションが提供されます。

- Next をクリックします。

- Review and Finish ページで、入力した情報を確認し、Review and Finish をクリックします。

- Red Hat Quay OIDC デプロイメントのチーム同期を有効にするには、Teams and membership ページで Enable Directory Sync をクリックします。

OIDC オーセンティケーターが Azure Entra ID の場合はグループオブジェクト ID を入力するように求められ、別のプロバイダーを使用している場合はグループ名を入力するように求められます。ポップアップのメッセージに注意してください。

警告チーム同期を有効にすると、すでにチームに所属しているユーザーのメンバーシップは取り消されることに注意してください。OIDC グループが信頼できる唯一の情報源となります。これは元に戻すことができないアクションです。Quay 内からのチームのユーザーメンバーシップは読み取り専用になります。

- Enable Sync をクリックします。

Teams and membership ページに戻ります。このチームのユーザーは削除され、ログインし直すと、再度追加されることに注意してください。この段階では、ロボットアカウントのみがまだチームの一部です。

ページ上部のバナーでチームが同期されていることを確認します。

This team is synchronized with a group in OIDC and its user membership is therefore read-only.

This team is synchronized with a group in OIDC and its user membership is therefore read-only.Copy to Clipboard Copied! Toggle word wrap Toggle overflow Directory Synchronization Config アコーディオンをクリックすると、デプロイメントが同期されている OIDC グループが表示されます。

- Red Hat Quay レジストリーからログアウトし、検証手順に進みます。

検証

以下の検証手順を使用して、user1 がチームのメンバーとして表示されることを確認します。

- Red Hat Quay レジストリーに再度ログインします。

-

Organizations → test-org → test-team Teams and memberships をクリックします。これで、

user1がこのチームのチームメンバーとして表示されます。

検証

以下の手順に従って、OIDC プロバイダー経由でグループから user1 を削除し、その後 Red Hat Quay のチームからも削除します。

- OIDC プロバイダーの管理コンソールに移動します。

- OIDC プロバイダーの Users ページに移動します。このページの名前はプロバイダーによって異なります。

-

Red Hat Quay に関連付けられているユーザーの名前 (例:

user1)をクリックします。 - 設定されたアイデンティティープロバイダーのグループからユーザーを削除します。

- ユーザーからアクセス権限を削除または割り当て解除します。

- Red Hat Quay レジストリーにログインします。

-

Organizations → test-org → test-team Teams and memberships をクリックします。

user1はこのチームから削除されました。

第11章 ロボットアカウントによるキーレス認証

Red Hat Quay の以前のバージョンでは、ロボットアカウントトークンは、削除または再生成されない限り、トークンの有効期間中有効でした。有効期限のないトークンは、長期的なパスワードの保存や、削除、再生成、新規認証トークンを管理を望まないユーザーにとって、セキュリティー上の問題を引き起こす可能性があります。

Red Hat Quay 3 では、Red Hat Quay 管理者は、Red Hat Single Sign-On (Keycloak プロジェクトに基づく) または Microsoft Entra ID を使用して、外部 OIDC トークンを短命または 一時的な ロボットアカウントトークンと交換できるようになります。これにより、ロボットアカウントは 1 時間有効のトークンを活用できるようになります。このようなトークンは定期的に更新され、個々のトランザクションの認証に使用できます。

この機能により、トークンを 1 時間後に削除することで、ロボットトークンの漏洩の可能性を軽減し、Red Hat Quay レジストリーのセキュリティーが大幅に向上します。

ロボットアカウントを使用したキーレス認証の設定には、ロボットフェデレーションの設定、OIDC プロバイダーからの OAuth2 トークンの生成、および OAuth2 トークンとロボットアカウントアクセストークンの交換を必要とする複数の手順があります。

11.1. Red Hat Sign Sign-On による OAuth2 トークンの生成

次の手順では、Red Hat Single Sign-On を使用して OAuth2 トークンを生成する方法を示します。OIDC プロバイダーに応じて、これらの手順は異なります。

手順

Red Hat Single Sign-On UI の場合は、以下を行います。

- Clients をクリックし、ユーザーの認証を要求できるアプリケーションまたはサービスの名前をクリックします。

クライアントの Settings ページで、次のオプションが設定または有効化されていることを確認します。

- クライアント ID

- 有効なリダイレクト URI

- クライアント認証

- 認可

- Standard flow

Direct access grants

注記設定はセットアップによって異なる場合があります。

- Credentials ページで、今後使用する時のために クライアントシークレット を保存します。

-

Users ページで、Add user をクリックし、ユーザー名 (例:

service-account-quaydev) を入力します。次に、Create をクリックします。 - Users ページで、ユーザーの名前 (例: service-account-quaydev) をクリックします。

- Credentials タブ → Set password をクリックし、ユーザーのパスワードを入力します。必要に応じて、Temporary オプションを選択して、このパスワードを一時的なものにすることができます。

Realm settings タブ → OpenID Endpoint Configuration をクリックします。

/protocol/openid-connect/tokenエンドポイントを保存します。以下に例を示します。http://localhost:8080/realms/master/protocol/openid-connect/token

http://localhost:8080/realms/master/protocol/openid-connect/tokenCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Web ブラウザーで、次の URL に移動します。

http://<keycloak_url>/realms/<realm_name>/protocol/openid-connect/auth?response_type=code&client_id=<client_id>

http://<keycloak_url>/realms/<realm_name>/protocol/openid-connect/auth?response_type=code&client_id=<client_id>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - プロンプトが表示されたら、service-account-quaydev ユーザーと設定した一時パスワードを使用してログインします。必要な情報を入力し、必要に応じて永続的なパスワードを設定してログインを完了します。

クライアントに提供された URI アドレスにリダイレクトされます。以下に例を示します。

https://localhost:3000/cb?session_state=5c9bce22-6b85-4654-b716-e9bbb3e755bc&iss=http%3A%2F%2Flocalhost%3A8080%2Frealms%2Fmaster&code=ea5b76eb-47a5-4e5d-8f71-0892178250db.5c9bce22-6b85-4654-b716-e9bbb3e755bc.cdffafbc-20fb-42b9-b254-866017057f43

https://localhost:3000/cb?session_state=5c9bce22-6b85-4654-b716-e9bbb3e755bc&iss=http%3A%2F%2Flocalhost%3A8080%2Frealms%2Fmaster&code=ea5b76eb-47a5-4e5d-8f71-0892178250db.5c9bce22-6b85-4654-b716-e9bbb3e755bc.cdffafbc-20fb-42b9-b254-866017057f43Copy to Clipboard Copied! Toggle word wrap Toggle overflow アドレスに記載されている

codeをメモしてください。以下に例を示します。code=ea5b76eb-47a5-4e5d-8f71-0892178250db.5c9bce22-6b85-4654-b716-e9bbb3e755bc.cdffafbc-20fb-42b9-b254-866017057f43

code=ea5b76eb-47a5-4e5d-8f71-0892178250db.5c9bce22-6b85-4654-b716-e9bbb3e755bc.cdffafbc-20fb-42b9-b254-866017057f43Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記これは 1 回のみ使用できる一時コードです。必要に応じて、ページを更新するか、URL に再度アクセスして別のコードを取得できます。

ターミナルで、次の

curl -X POSTコマンドを使用して一時的な OAuth2 アクセストークンを生成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

{"access_token":"eyJhbGciOiJSUzI1NiIsInR5cCIgOiAiSldUIiwia2lkIiA6ICJTVmExVHZ6eDd2cHVmc1dkZmc1SHdua1ZDcVlOM01DN1N5T016R0QwVGhVIn0...", "expires_in":60,"refresh_expires_in":1800,"refresh_token":"eyJhbGciOiJIUzUxMiIsInR5cCIgOiAiSldUIiwia2lkIiA6ICJiNTBlZTVkMS05OTc1LTQwMzUtYjNkNy1lMWQ5ZTJmMjg0MTEifQ.oBDx6B3pUkXQO8m-M3hYE7v-w25ak6y70CQd5J8f5EuldhvTwpWrC1K7yOglvs09dQxtq8ont12rKIoCIi4WXw","token_type":"Bearer","not-before-policy":0,"session_state":"5c9bce22-6b85-4654-b716-e9bbb3e755bc","scope":"profile email"}{"access_token":"eyJhbGciOiJSUzI1NiIsInR5cCIgOiAiSldUIiwia2lkIiA6ICJTVmExVHZ6eDd2cHVmc1dkZmc1SHdua1ZDcVlOM01DN1N5T016R0QwVGhVIn0...", "expires_in":60,"refresh_expires_in":1800,"refresh_token":"eyJhbGciOiJIUzUxMiIsInR5cCIgOiAiSldUIiwia2lkIiA6ICJiNTBlZTVkMS05OTc1LTQwMzUtYjNkNy1lMWQ5ZTJmMjg0MTEifQ.oBDx6B3pUkXQO8m-M3hYE7v-w25ak6y70CQd5J8f5EuldhvTwpWrC1K7yOglvs09dQxtq8ont12rKIoCIi4WXw","token_type":"Bearer","not-before-policy":0,"session_state":"5c9bce22-6b85-4654-b716-e9bbb3e755bc","scope":"profile email"}Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

前の手順の

access_tokenを保存します。これは次の手順で Red Hat Quay ロボットアカウントトークンと交換されます。

11.2. Red Hat Quay v2 UI を使用してロボットアカウントフェデレーションを設定する

次の手順では、Red Hat Quay v2 UI を使用してロボットアカウントフェデレーションをセットアップする方法を示します。この手順では、Keycloak プロジェクトに基づく Red Hat Single Sign-On を使用します。これらの手順と、ロボットアカウントフェデレーションのセットアップに使用される情報は、OIDC プロバイダーによって異なります。

前提条件

-

組織を作成している。次の例では

fed_testを使用します。 -

ロボットアカウントを作成している。次の例では、

fest_test+robot1を使用します。 - Red Hat Quay デプロイメント用に OIDC を設定している。次の例では、Red Hat Single Sign-On を使用します。

手順

Red Hat Single Sign-On のメインページで、以下を行います。

-

Red Hat Quay で使用するために認証された適切なレルムを選択します。issuer URL を保存します (例:

https://keycloak-auth-realm.quayadmin.org/realms/quayrealm)。 - Users →認証のためにロボットアカウントにリンクするユーザーの名前をクリックします。OAuth2 アクセストークンを生成するときに使用したのと同じユーザーアカウントを使用する必要があります。

Details ページで、ユーザーの ID (例:

449e14f8-9eb5-4d59-a63e-b7a77c75f770) を保存します。注記このステップで収集される情報は、OIDC プロバイダーによって異なります。たとえば、Red Hat Single Sign-On では、ユーザーの ID が Subject として使用され、後続のステップでロボットアカウントフェデレーションがセットアップされます。Microsoft Entra ID などの別の OIDC プロバイダーの場合、この情報は Subject として保存されます。

-

Red Hat Quay で使用するために認証された適切なレルムを選択します。issuer URL を保存します (例:

Red Hat Quay レジストリーの場合、以下を行います。

- Organizations に移動し、組織の名前 (例: fed_test) をクリックします。

- Robot Accounts をクリックします。

- 縦の省略記号メニュー → Set robot federation をクリックします。

- + 記号をクリックします。

ポップアップウィンドウに次の情報を入力します。

-

Issuer URL:

https://keycloak-auth-realm.quayadmin.org/realms/quayrealm。Red Hat Single Sign-On の場合、これは Red Hat Single Sign-On レルムの URL になります。これは、OIDC プロバイダーによって異なる場合があります。 -

Subject:

449e14f8-9eb5-4d59-a63e-b7a77c75f770。Red Hat Single Sign-On の場合、Subject は Red Hat Single Sign-On ユーザーの ID になります。これは OIDC プロバイダーによって異なります。たとえば、Microsoft Entra ID を使用している場合、Subject は Subject または Entra ID ユーザーになります。

-

Issuer URL:

- Save をクリックします。

11.3. OAuth2 アクセストークンを Red Hat Quay ロボットアカウントトークンと交換する

次の手順では、前の手順で生成された access token を利用して、新しい Red Hat Quay ロボットアカウントトークンを作成します。新しい Red Hat Quay ロボットアカウントトークンは、OIDC プロバイダーと Red Hat Quay 間の認証に使用されます。

次の例では、Python スクリプトを使用して、OAuth2 アクセストークンを Red Hat Quay ロボットアカウントトークンと交換します。

前提条件

-

python3CLI ツールがインストールされている。

手順

次の Python スクリプトを

.pyファイル (例:robot_fed_token_auth.py) に保存します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Red Hat Quay デプロイメントでカスタム SSL/TLS 証明書を使用している場合、応答は

response = requests.get(URL,auth=(robot_user,fed_token),verify=False)ある必要があり、これにはverify=Falseフラグが含まれます。

OAuth2 アクセストークンを

TOKENとしてエクスポートします。以下に例を示します。export TOKEN = eyJhbGciOiJSUzI1NiIsInR5cCIgOiAiSldUIiwia2lkIiA6ICJTVmExVHZ6eDd2cHVmc1dkZmc1SHdua1ZDcVlOM01DN1N5T016R0QwVGhVIn0...

$ export TOKEN = eyJhbGciOiJSUzI1NiIsInR5cCIgOiAiSldUIiwia2lkIiA6ICJTVmExVHZ6eDd2cHVmc1dkZmc1SHdua1ZDcVlOM01DN1N5T016R0QwVGhVIn0...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して

robot_fed_token_auth.pyスクリプトを実行します。python3 robot_fed_token_auth.py

$ python3 robot_fed_token_auth.pyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

<Response [200]> {"token": "string..."}<Response [200]> {"token": "string..."}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要このトークンは 1 時間が経過すると期限切れになります。1 時間後、新しいトークンを生成する必要があります。

ロボットアカウントアクセストークンを

QUAY_TOKENとしてエクスポートします。以下に例を示します。export QUAY_TOKEN=291cmNlX2FjY2VzcyI6eyJhY2NvdW50Ijp7InJvbGVzIjpbIm1hbmFnZS1hY2NvdW50IiwibWFuYWdlLWFjY291bnQtbGlua3MiLCJ2aWV3LXByb2ZpbGUiXX19LCJzY29wZSI6InByb2ZpbGUgZW1haWwiLCJlbWFpbF92ZXJpZ

$ export QUAY_TOKEN=291cmNlX2FjY2VzcyI6eyJhY2NvdW50Ijp7InJvbGVzIjpbIm1hbmFnZS1hY2NvdW50IiwibWFuYWdlLWFjY291bnQtbGlua3MiLCJ2aWV3LXByb2ZpbGUiXX19LCJzY29wZSI6InByb2ZpbGUgZW1haWwiLCJlbWFpbF92ZXJpZCopy to Clipboard Copied! Toggle word wrap Toggle overflow

11.4. イメージのプッシュとプル

新しいロボットアカウントアクセストークンを生成してエクスポートしたら、アクセストークンを使用してロボットアカウントにログインし、イメージをプッシュおよびプルできます。

前提条件

- OAuth2 アクセストークンを新しいロボットアカウントアクセストークンにエクスポートしている。

手順

fest_test+robot1ロボットアカウントとQUAY_TOKENアクセストークンを使用して、Red Hat Quay レジストリーにログインします。以下に例を示します。podman login <quay-server.example.com> -u fed_test+robot1 -p $QUAY_TOKEN

$ podman login <quay-server.example.com> -u fed_test+robot1 -p $QUAY_TOKENCopy to Clipboard Copied! Toggle word wrap Toggle overflow ロボットアカウントに適切な権限がある Red Hat Quay リポジトリーからイメージをプルします。以下に例を示します。

podman pull <quay-server.example.com/<repository_name>/<image_name>>

$ podman pull <quay-server.example.com/<repository_name>/<image_name>>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ロボットアカウントに適切な権限が ない Red Hat Quay リポジトリーからイメージをプルしようとしました。以下に例を示します。

podman pull <quay-server.example.com/<different_repository_name>/<image_name>>

$ podman pull <quay-server.example.com/<different_repository_name>/<image_name>>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Error: initializing source docker://quay-server.example.com/example_repository/busybox:latest: reading manifest in quay-server.example.com/example_repository/busybox: unauthorized: access to the requested resource is not authorized

Error: initializing source docker://quay-server.example.com/example_repository/busybox:latest: reading manifest in quay-server.example.com/example_repository/busybox: unauthorized: access to the requested resource is not authorizedCopy to Clipboard Copied! Toggle word wrap Toggle overflow このロボットアカウントの認証情報は、1 時間後に期限切れになるよう設定されています。その後、このロボットアカウントの新しいアクセストークンを生成する必要があります。

第12章 AWS STS for Red Hat Quay の設定

Amazon Web Services (AWS) Security Token Service (STS) のサポートは、スタンドアロンの Red Hat Quay デプロイメント、Red Hat Quay on OpenShift Container Platform、および Red Hat OpenShift Service on AWS (ROSA) で利用できます。AWS STS は、AWS アイデンティティーおよびアクセス管理 (IAM) ユーザー、認証したユーザー、または フェデレーションユーザー に対して、一時的な制限付き権限の認証情報をリクエストするための Web サービスです。この機能は、Amazon S3 をオブジェクトストレージとして使用するクラスターに役立ち、Red Hat Quay は STS プロトコルを使用して Amazon S3 で認証できます。これにより、クラスターの全体的なセキュリティーが強化され、機密データへのアクセスが適切に認証および承認される際に役立ちます。

OpenShift Container Platform または ROSA 用に AWS STS を設定するには、AWS IAM ユーザーを作成し、S3 ロールを作成し、適切なリソースを含めるように Red Hat Quay config.yaml ファイルを設定する必要があります。

AWS STS for Red Hat Quay を設定するには、次の手順に従います。

12.1. AWS STS を使用するための Red Hat Quay の設定

AWS STS を使用するために Red Hat Quay config.yaml ファイルを編集するには、次の手順に従います。

手順

Red Hat Quay の

config.yamlファイルを更新して、次の情報を追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Quay デプロイメントを再起動します。

検証

リポジトリーにプッシュされるサンプルイメージ (例:

busybox) にタグを付けます。以下に例を示します。podman tag docker.io/library/busybox <quay-server.example.com>/<organization_name>/busybox:test

$ podman tag docker.io/library/busybox <quay-server.example.com>/<organization_name>/busybox:testCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、サンプルイメージをプッシュします。

podman push <quay-server.example.com>/<organization_name>/busybox:test

$ podman push <quay-server.example.com>/<organization_name>/busybox:testCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Quay registry → Tags でイメージをプッシュした Organization に移動して、プッシュが成功したことを確認します。

- Amazon Web Services (AWS) コンソールに移動し、s3 バケットを探します。

- s3 バケットの名前をクリックします。

- Objects ページで、datastorage/ をクリックします。

datastorage/ ページには、次のリソースが表示されます。

- sha256/

uploads/

これらのリソースは、プッシュが成功し、AWS STS が適切に設定されていることを示しています。

第13章 Red Hat Quay の下での Prometheus および Grafana のメトリック

Red Hat Quay は、各インスタンスに Prometheus と Grafana に対応したエンドポイントをエクスポートし、簡単にモニタリングとアラートを行うことができます。

13.1. Prometheus エンドポイントの公開

13.1.1. スタンドアロン Red Hat Quay

podman run を使用して Quay コンテナーを起動する場合は、メトリックポート 9091 を公開します。

sudo podman run -d --rm -p 80:8080 -p 443:8443 -p 9091:9091\ --name=quay \ -v $QUAY/config:/conf/stack:Z \ -v $QUAY/storage:/datastorage:Z \ registry.redhat.io/quay/quay-rhel8:v3.15.1

$ sudo podman run -d --rm -p 80:8080 -p 443:8443 -p 9091:9091\

--name=quay \

-v $QUAY/config:/conf/stack:Z \

-v $QUAY/storage:/datastorage:Z \

registry.redhat.io/quay/quay-rhel8:v3.15.1これでメトリックが利用可能になります。

curl quay.example.com:9091/metrics

$ curl quay.example.com:9091/metricsQuay のリポジトリーカウントを監視するための Prometheus および Grafana の設定は、Monitoring Quay with Prometheus and Grafana を参照してください。

13.1.2. Red Hat Quay Operator

quay-metrics サービスのクラスター IP を判別します。

クラスターに接続し、quay-metrics サービスのクラスター IP およびポートを使用してメトリックにアクセスします。

13.1.3. Prometheus がメトリックを消費するための設定

Prometheus は、クラスター内で実行されているすべての Red Hat Quay インスタンスにアクセスする方法が必要です。典型的なセットアップでは、すべての Red Hat Quay インスタンスを単一の名前付き DNS エントリーにリストアップし、それを Prometheus に渡すことで行われます。

13.1.4. Kubernetes での DNS 設定

シンプルな Kubernetes service を設定して、Prometheus の DNS エントリーを提供することができます。

13.1.5. 手動クラスターの DNS 設定

SkyDNS は、Kubernetes を使用していない場合に、この DNS レコードを管理するためのシンプルなソリューションです。SkyDNS は、etcd クラスター上で動作させることができます。クラスター内の各 Red Hat Quay インスタンスのエントリーを etcd ストアに追加、削除することができます。SkyDNS はそこから定期的に読み込んで、それに応じて DNS レコードの Quay インスタンスのリストを更新します。

13.2. メトリックの概要

Red Hat Quay には、一般的なレジストリーの使用、アップロード、ダウンロード、ガベージコレクション、および認証のメトリックなど、レジストリーの監視に役立つメトリックが同梱されています。

13.2.1. 一般レジストリーの統計

一般的なレジストリー統計で、どの程度レジストリーが拡大しているかが分かります。

| メトリクス名 | 説明 |

|---|---|

| quay_user_rows | データベースのユーザー数 |

| quay_robot_rows | データベースのロボットアカウントの数 |

| quay_org_rows | データベースの組織数 |

| quay_repository_rows | データベースのリポジトリー数 |

| quay_security_scanning_unscanned_images_remaining_total | 最新のセキュリティースキャナーによってスキャンされないイメージの数 |

メトリックの出力サンプル

13.2.2. キューアイテム

キューアイテム メトリックでは、作業管理用に Quay が使用する複数のキューに関する情報が分かります。

| メトリクス名 | 説明 |

|---|---|

| quay_queue_items_available | 特定のキュー内のアイテム数 |

| quay_queue_items_locked | 実行中のアイテム数 |

| quay_queue_items_available_unlocked | 処理を待機しているアイテム数 |

メトリックラベル

QUEUE_NAME: キューの名前。以下のいずれかになります。

- exportactionlogs: アクションログをエクスポートするためのキューに追加されている要求。これらのログは処理され、ストレージに配置されます。その後、リンクがメールを介して要求元に送信されます。

- namespacegc: キューに追加されてガベージコレクションされる namespace

- notification: リポジトリー通知が送信されるキュー

- repositorygc: ガベージコレクションを行うレポジトリーでキューに追加されているもの

- secscanv4: Clair V4 に固有の通知キュー

- dockerfilebuild: Quay docker ビルドのキュー

- imagestoragereplication: 複数のストレージで複製されるようにキューに追加されている Blob

- chunk_cleanup: 削除する必要があり、キューに追加されている Blob セグメント。これは、一部のストレージ実装 (Swift など) でのみ使用されます。

たとえば、キューラベルの repositorygc には、リポジトリーのガべージコレクションワーカーによって削除対象としてマークされたリポジトリーが含まれます。repositorygc の queue_name ラベル付きのメトリックの場合は、以下のようになります。

- quay_queue_items_locked は、現在削除されているリポジトリーの数です。

- quay_queue_items_available_unlocked は、ワーカーが処理するのを待機するリポジトリーの数です。

メトリックの出力サンプル

13.2.3. ガベージコレクションメトリック

これらのメトリックは、ガベージコレクション (gc) から削除されたリソースの数を示します。ここでは、gc ワーカーが実行した回数と、削除された namespace、リポジトリー、および Blob の数が示されます。

| メトリクス名 | 説明 |

|---|---|

| quay_gc_iterations_total | GCWorker による反復の数 |

| quay_gc_namespaces_purged_total | NamespaceGCWorker によってパージされる namespace 数 |

| quay_gc_repos_purged_total | RepositoryGCWorker または NamespaceGCWorker がパージするリポジトリーの数 |

| quay_gc_storage_blobs_deleted_total | 削除されたストレージ Blob の数 |

メトリックの出力サンプル

13.2.3.1. マルチパートアップロードメトリック

マルチパートアップロードメトリックは、ストレージへの Blob アップロードの数 (S3、Rados、GoogleCloudStorage、RHOCS) を表示します。これらは、Quay が Blob をストレージに正しくアップロードできない場合の問題を特定するのに役立ちます。

| メトリクス名 | 説明 |

|---|---|

| quay_multipart_uploads_started_total | 起動した Quay ストレージへのマルチパートアップロードの数 |

| quay_multipart_uploads_completed_total | 完了した Quay ストレージへのマルチパートアップロードの数 |

メトリックの出力サンプル

13.2.4. イメージのプッシュ/プルのメトリック

イメージのプッシュおよびプルに関連する数多くのメトリックを利用できます。

13.2.4.1. イメージプルの合計

| メトリクス名 | 説明 |

|---|---|

| quay_registry_image_pulls_total | レジストリーからダウンロードされたイメージの数 |

メトリックラベル

- protocol: 使用するレジストリープロトコル (常に v2 に指定する)

- ref: -tag マニフェストのプルに使用する ref

- status: 要求の http 戻りコード

13.2.4.2. プルしたイメージ (バイト)

| メトリクス名 | 説明 |

|---|---|

| quay_registry_image_pulled_estimated_bytes_total | レジストリーからダウンロードされたバイト数 |

メトリックラベル

- protocol: 使用するレジストリープロトコル (常に v2 に指定する)

13.2.4.3. イメージのプッシュ合計

| メトリクス名 | 説明 |

|---|---|

| quay_registry_image_pushes_total | レジストリーからアップロードされたイメージの数 |

メトリックラベル

- protocol: 使用するレジストリープロトコル (常に v2 に指定する)

- pstatus: 要求の http 戻りコード

- pmedia_type: アップロードしたマニフェストタイプ

13.2.4.4. プッシュされたイメージバイト

| メトリクス名 | 説明 |

|---|---|

| quay_registry_image_pushed_bytes_total | レジストリーにアップロードされたバイト数 |

メトリックの出力サンプル

# HELP quay_registry_image_pushed_bytes_total number of bytes pushed to the registry

# TYPE quay_registry_image_pushed_bytes_total counter

quay_registry_image_pushed_bytes_total{host="example-registry-quay-app-6df87f7b66-9tfn6",instance="",job="quay",pid="221",process_name="registry:application"} 0

...

# HELP quay_registry_image_pushed_bytes_total number of bytes pushed to the registry

# TYPE quay_registry_image_pushed_bytes_total counter

quay_registry_image_pushed_bytes_total{host="example-registry-quay-app-6df87f7b66-9tfn6",instance="",job="quay",pid="221",process_name="registry:application"} 0

...13.2.5. 認証メトリック

認証メトリックでは、タイプ別にラベルが付けられた認証要求の数と、成功したかどうかが分かります。たとえば、このメトリックを使用して、失敗した Basic 認証要求を監視できます。

| メトリクス名 | 説明 |

|---|---|

| quay_authentication_attempts_total | レジストリーおよび API 全体で認証を試行する回数 |

メトリックラベル

auth_kind: 使用される認証のタイプ。以下が含まれます。

- basic

- oauth

- credentials

- success: true または false

メトリックの出力サンプル

第14章 Red Hat Quay クォータの管理と適用の概要

Red Hat Quay を使用すると、スーパーユーザー特権を持つ管理者は、ストレージの消費量を報告し、設定されたストレージクォータ制限を確立してレジストリーの増加を抑制することができます。Red Hat Quay スーパーユーザーは、次の方法で環境の容量制限を管理できます。

- クォータレポート: この設定を使用すると、管理者はすべての組織のストレージ消費量を追跡できます。さらに、ユーザーは割り当てられた組織のストレージ消費量を追跡できます。

- クォータ管理: この設定を使用すると、管理者は Red Hat Quay ユーザーに対してソフトチェックとハードチェックを定義できます。ソフトチェックは、組織のストレージ消費量が設定されたしきい値に達しているかどうかをユーザーに通知します。ハードチェックは、ストレージ消費量が設定された制限に達したときにユーザーがレジストリーにプッシュするのを防ぎます。

クォータは、レジストリー全体に対して、またはレジストリー内の特定のリポジトリーに対して設定できます。

これらの機能を総合的に活用することで、Red Hat Quay レジストリーのサービス所有者はサービスレベルアグリーメントを定義し、健全なリソース予算をサポートできるようになります。

14.1. クォータ管理の制限

クォータ管理機能の 1 つの制限は、アーティファクトのプッシュ時にリソース消費量を計算すると、その計算がプッシュのクリティカルパスの一部になることです。これがないと、使用状況データがドリフトする可能性があります。

最大ストレージクォータサイズは、選択したデータベースによって異なります。

| 変数 | 説明 |

|---|---|

| Postgres | 8388608 TB |

| MySQL | 8388608 TB |

| SQL Server | 16777216 TB |

14.2. システム全体のデフォルトクォータの設定

すべての組織およびユーザーに適用されるシステム全体のデフォルトのストレージクォータを指定するには、DEFAULT_SYSTEM_REJECT_QUOTA_BYTES 設定フラグを使用します。このフィールドが設定され、クォータ制限に達した場合、システムは新しいアーティファクトを自動的に拒否します。デフォルトでは、この設定フィールドは無効になっています。

組織またはユーザーに対して特定のクォータを設定し、そのクォータを削除すると、システム全体のデフォルトのクォータ (設定されている場合) が適用されます。同様に、組織またはユーザーに対して特定のクォータを設定してから、システム全体のデフォルトのクォータを変更すると、更新されたシステム全体のデフォルトによって特定の設定が上書きされます。

次の手順では、システム全体のデフォルトクォータを設定する方法を示します。

手順

config.yamlファイルにDEFAULT_SYSTEM_REJECT_QUOTA_BYTESフィールドを追加して、システム全体のデフォルトのストレージクォータを設定します。以下に例を示します。# ... DEFAULT_SYSTEM_REJECT_QUOTA_BYTES: 100gb # ...

# ... DEFAULT_SYSTEM_REJECT_QUOTA_BYTES: 100gb # ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Quay レジストリーを再起動します。

14.3. Red Hat Quay UI を使用して組織のクォータを確立する

次の手順では、リポジトリーのストレージ消費量を報告し、ストレージクォータ制限を確立する方法について説明します。

前提条件

- スーパーユーザーアカウント

- クォータ制限の要求を満たすのに十分なストレージ

手順

config.yamlファイルでFEATURE_QUOTA_MANAGEMENT: Trueを設定し、レジストリーを再起動します。以下に例を示します。# ... FEATURE_QUOTA_MANAGEMENT: True # ...

# ... FEATURE_QUOTA_MANAGEMENT: True # ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 新しい組織を作成するか、既存の組織を選択します。

- スーパーユーザーとしてレジストリーにログインし、Super User Admin Panel の Manage Organizations タブに移動します。ストレージクォータ制限を作成する組織の オプション アイコンをクリックします。

- [クォータの設定] をクリックします。

- ストレージクォータの設定 では、初期クォータ (例: 10 MiB) を入力します。次に、適用 をクリックします。

オプション: クォータポリシー の場合は、次のいずれかの アクション を選択します。次に、クォータしきい値 を入力し、制限の追加 をクリックします。

- 拒否: このオプションを選択すると、設定されたクォータを超えるアーティファクトはすべて拒否されます。

警告: このオプションを選択すると、設定されたクォータを超えるプッシュされたアーティファクトがユーザーに通知されますが、アーティファクトは正常にプッシュされます。

注記クォータしきい値パーセントは、リポジトリーが割り当てられたストレージクォータに近づいていることを Red Hat Quay がユーザーに警告し始めるタイミングを決定します。

検証

次のコマンドを入力してサンプルアーティファクトをプルします。

podman pull busybox

$ podman pull busyboxCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、サンプルアーティファクトにタグを付けます。

podman tag docker.io/library/busybox quay-server.example.com/testorg/busybox:test

$ podman tag docker.io/library/busybox quay-server.example.com/testorg/busybox:testCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、サンプルアーティファクトを組織にプッシュします。

podman push --tls-verify=false quay-server.example.com/testorg/busybox:test

$ podman push --tls-verify=false quay-server.example.com/testorg/busybox:testCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Quay UI の スーパーユーザー管理パネル に移動し、組織の管理を クリックします。組織 ページには、アーティファクトによって使用されるクォータの合計割合が表示されます。

オプション: 次のコマンドを入力して、設定されたクォータを超える意図で 2 番目のサンプルアーティファクトをプルします。

podman pull nginx

$ podman pull nginxCopy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: 次のコマンドを入力して、2 番目のアーティファクトにタグを付けます。

podman tag docker.io/library/nginx quay-server.example.com/testorg/nginx

$ podman tag docker.io/library/nginx quay-server.example.com/testorg/nginxCopy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: 次のコマンドを入力して、2 番目のアーティファクトを組織にプッシュします。

podman push --tls-verify=false quay-server.example.com/testorg/nginx

$ podman push --tls-verify=false quay-server.example.com/testorg/nginxCopy to Clipboard Copied! Toggle word wrap Toggle overflow アーティファクトが定義されたクォータを超え、クォータポリシー を Reject に設定すると、次のエラーメッセージが返されます。

denied: Quota has been exceeded on namespace

denied: Quota has been exceeded on namespaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow アーティファクトが定義されたクォータを超え、クォータポリシー を Warning に設定すると、エラーメッセージは返されず、イメージは正常にプッシュされます。

拒否 ポリシーと 警告 ポリシーの両方の通知も、ベル アイコンをクリックすると Red Hat Quay UI に返されます。

14.4. API を使用してクォータ制限を管理する

組織を初めて作成した時点では、クォータは設定されていません。API を使用して、組織のクォータ制限を確認、作成、変更、または削除できます。

前提条件

- OAuth アクセストークンを生成した。

14.4.1. API を使用したクォータの設定

Red Hat Quay API を使用してクォータ制限を設定するには、次の手順に従います。

手順

組織のクォータを設定するには、

POST /api/v1/organization/{orgname}/quotaエンドポイントを使用します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

"Created"

"Created"Copy to Clipboard Copied! Toggle word wrap Toggle overflow GET /api/v1/organization/{orgname}/quotaコマンドを使用して、組織にクォータがすでに設定されているか確認します。curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' https://<quay-server.example.com>/api/v1/organization/<organization_name>/quota | jq

$ curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' https://<quay-server.example.com>/api/v1/organization/<organization_name>/quota | jqCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

[{"id": 1, "limit_bytes": 10737418240, "limit": "10.0 GiB", "default_config": false, "limits": [], "default_config_exists": false}][{"id": 1, "limit_bytes": 10737418240, "limit": "10.0 GiB", "default_config": false, "limits": [], "default_config_exists": false}]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 既存のクォータ制限を変更するには、

PUT /api/v1/organization/{orgname}/quota/{quota_id}コマンドを使用します。以下に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

{"id": 1, "limit_bytes": 21474836480, "limit": "20.0 GiB", "default_config": false, "limits": [], "default_config_exists": false}{"id": 1, "limit_bytes": 21474836480, "limit": "20.0 GiB", "default_config": false, "limits": [], "default_config_exists": false}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

14.4.2. API を使用してクォータの使用状況を表示する

Red Hat Quay API を使用してクォータの使用状況を表示するには、次の手順に従います。

手順

消費されたストレージを表示するには、/api/v1/repository エンドポイントからデータを

GETします。サンプルコマンド

curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' 'https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/repository?last_modified=true&namespace=testorg&popularity=true&public=true' | jq

$ curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' 'https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/repository?last_modified=true&namespace=testorg&popularity=true&public=true' | jqCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 組織内のリポジトリーのクォータレポートを表示するには、/api/v1/repository エンドポイントを使用します。

サンプルコマンド