Red Hat Quay Operator の機能

第1章 連邦情報処理標準 (FIPS) の準備と準拠

米国国立標準技術研究所 (NIST) によって開発された連邦情報処理標準 (FIPS) は、特に銀行、医療、公共部門などの高度に規制された分野で、機密データを保護および暗号化するために高く評価されていると見なされています。Red Hat Enterprise Linux (RHEL) および OpenShift Container Platform は FIPS モード を提供することで FIPS をサポートします。このモードでは、システムは openssl などの特定の FIPS 検証済み暗号モジュールの使用のみを許可します。これにより、FIPS への準拠が保証されます。

1.1. FIPS コンプライアンスの有効化

以下の手順を使用して、Red Hat Quay デプロイメントで FIPS コンプライアンスを有効にします。

前提条件

- Red Hat Quay のスタンドアロンデプロイメントを実行している場合、Red Hat Enterprise Linux (RHEL) デプロイメントがバージョン 8 以降であり、FIPS が有効である。

- Red Hat Quay を OpenShift Container Platform にデプロイしている場合、OpenShift Container Platform がバージョン 4.10 以降である。

- Red Hat Quay のバージョンが 3.5.0 以降である。

IBM Power または IBM Z クラスター上の OpenShift Container Platform で Red Hat Quay を使用している場合:

- OpenShift Container Platform バージョン 4.14 以降

- Red Hat Quay バージョン 3.10 以降

- Red Hat Quay デプロイメントの管理者権限がある。

手順

Red Hat Quay

config.yamlファイルで、FEATURE_FIPS設定フィールドをTrueに設定します。以下に例を示します。--- FEATURE_FIPS = true ---

--- FEATURE_FIPS = true ---Copy to Clipboard Copied! Toggle word wrap Toggle overflow FEATURE_FIPSをTrueに設定すると、Red Hat Quay は FIPS 準拠のハッシュ関数を使用して実行されます。

第2章 コンソールでのモニタリングおよびアラート

Red Hat Quay では、OpenShift Container Platform コンソール内から Red Hat Quay Operator を使用してデプロイされたインスタンスのモニタリングがサポートされています。新規のモニタリング機能には、Grafana ダッシュボード、個別のメトリクスへのアクセス、Quay Pod を頻繁に再起動するために通知するアラートなどが含まれます。

監視機能を有効にするには、Red Hat Quay Operator をインストールするときに、インストールモードとして クラスター上のすべての namespace を選択する必要があります。

2.1. Dashboard

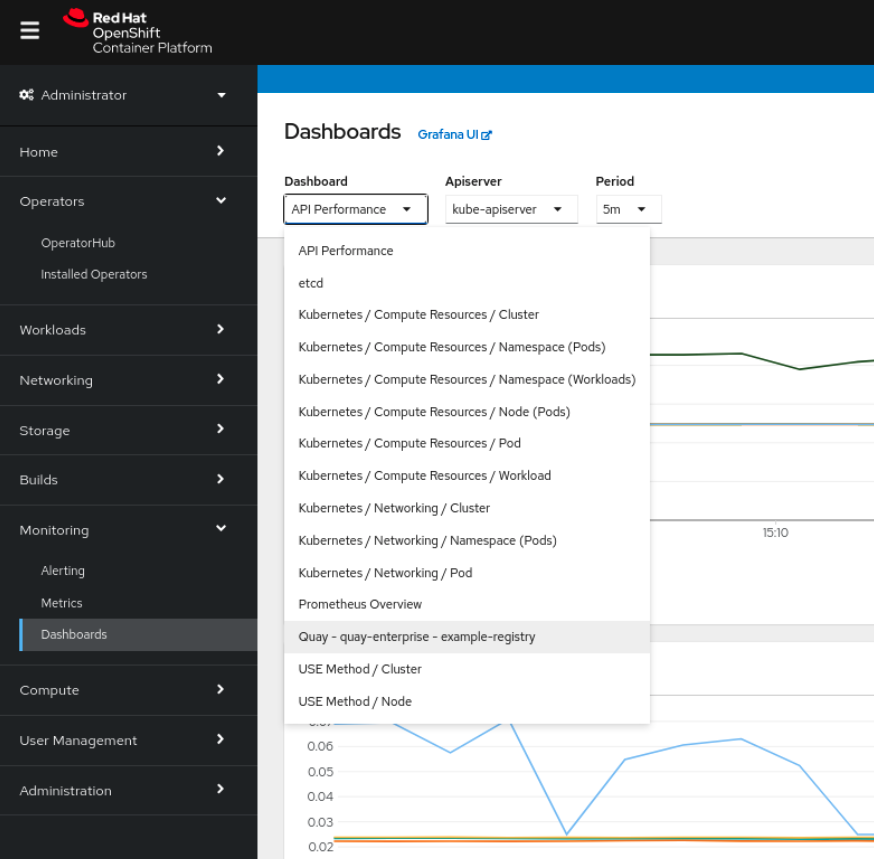

OpenShift Container Platform コンソールで、Monitoring → Dashboards をクリックし、目的の Red Hat Quay レジストリーインスタンスのダッシュボードを検索します。

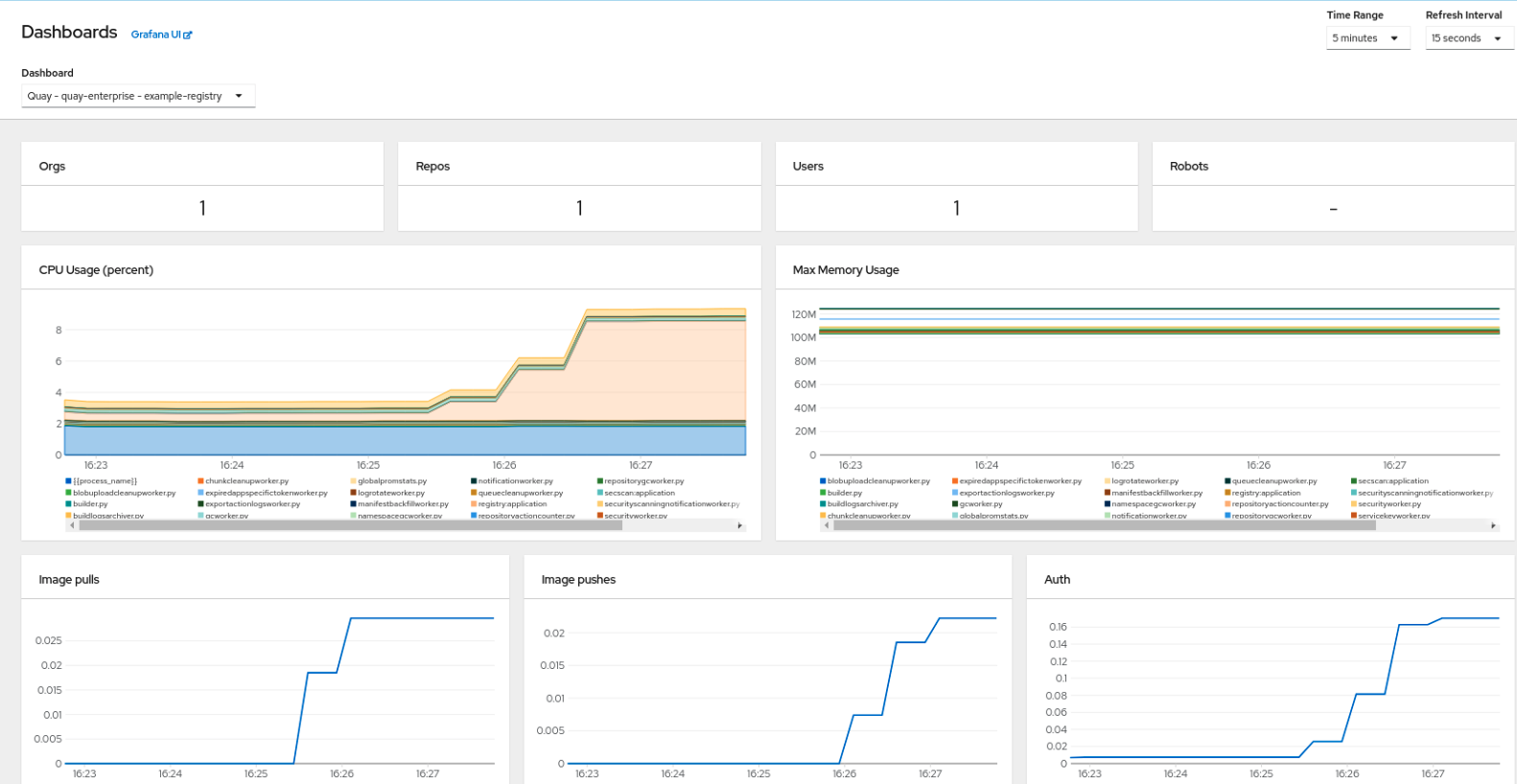

ダッシュボードには、次を含む統計情報が表示されます。

- Organizations、Repositories、Users、Robot accounts の数

- CPU の使用率

- 最大メモリー使用量

- プル、プッシュ、認証要求のレート

- API 要求のレート

- 待機時間

2.2. メトリクス

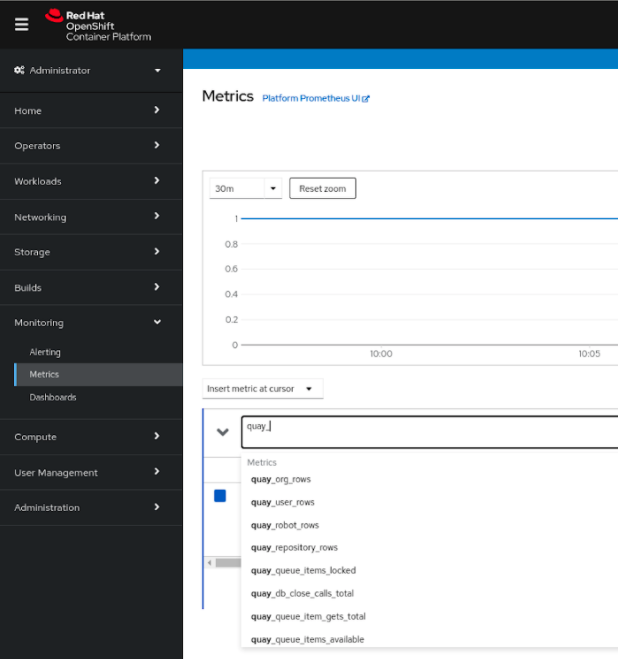

UI で Monitoring → Metrics にアクセスすると、Red Hat Quay ダッシュボードの背後にある基礎となるメトリクスを表示できます。Expression フィールドに quay_ を入力し、利用可能なメトリクスのリストを表示します。

quay_org_rows など、サンプルメトリックを選択します。

このメトリクスは、レジストリー内の組織の数を示します。ダッシュボードにも直接表示されます。

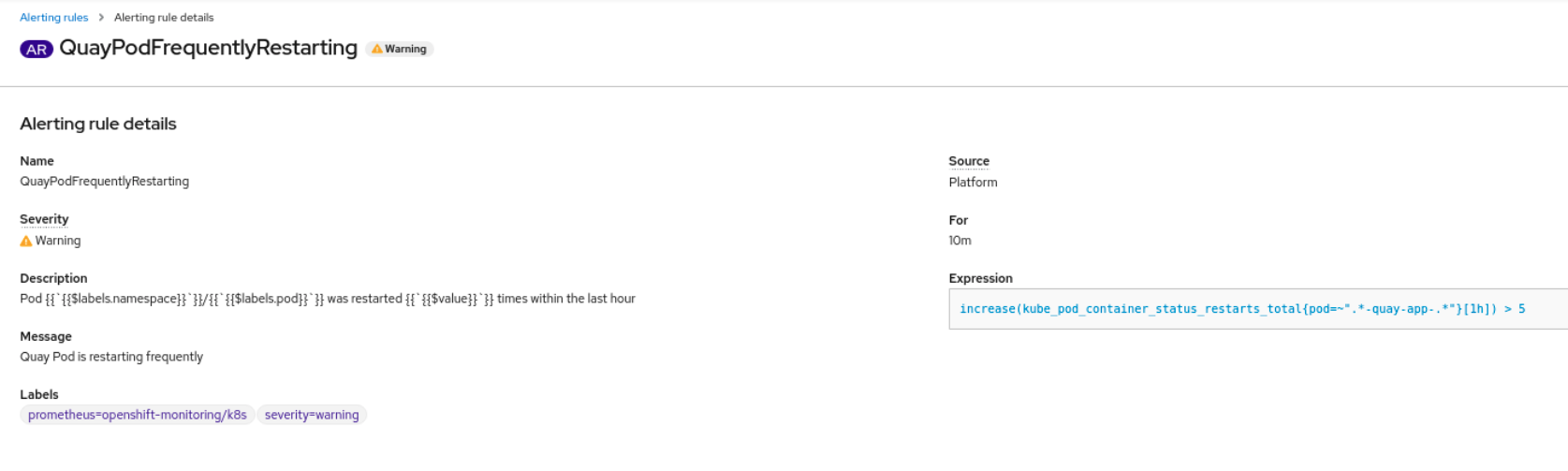

2.3. アラート

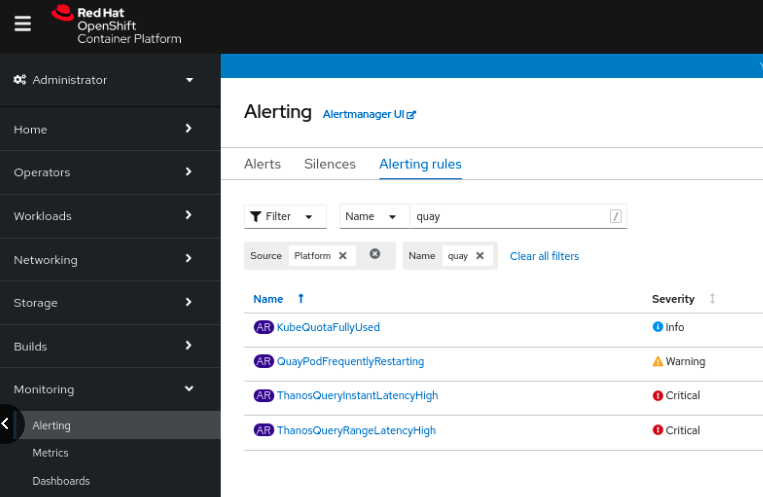

Quay Pod が頻繁に再起動する場合はアラートが発生します。アラートを設定するには、コンソール UI の Monitoring → Alerting で Alerting ルールタブにアクセスし、Quay 固有のアラートを検索します。

QuayPodFrequentlyRestarting ルールの詳細を選択し、アラートを設定します。

第3章 Clair セキュリティースキャナー

3.1. Clair 脆弱性データベース

Clair は、次の脆弱性データベースを使用して、イメージの問題を報告します。

- Ubuntu Oval データベース

- Debian Security Tracker

- Red Hat Enterprise Linux (RHEL) Oval データベース

- SUSE Oval データベース

- Oracle Oval データベース

- アルパイン SecDB データベース

- VMware Photon OS データベース

- Amazon Web Services (AWS) UpdateInfo

- Open Source Vulnerability (OSV) Database

Clair がさまざまなデータベースでセキュリティーマッピングを行う方法は、Claircore Severity Mapping を参照してください。

3.1.1. Clair の Open Source Vulnerability (OSV) データベースに関する情報

Open Source Vulnerability (OSV) は、オープンソースソフトウェアのセキュリティー脆弱性の追跡と管理に重点を置いた脆弱性データベースおよび監視サービスです。

OSV は、オープンソースプロジェクトにおける既知のセキュリティー脆弱性の包括的かつ最新のデータベースを提供します。ソフトウェア開発で使用されるライブラリー、フレームワーク、その他のコンポーネントを含む、幅広いオープンソースソフトウェアを対象としています。対象エコシステムの完全なリストは、定義されているエコシステム を参照してください。

Clair は、Open Source Vulnerability (OSV) データベースを通じて、golang、java、および ruby エコシステムの脆弱性とセキュリティー情報も報告します。

開発者や組織は、OSV を活用することで、使用するオープンソースコンポーネントのセキュリティー脆弱性をプロアクティブに監視して対処できるため、プロジェクトにおけるセキュリティー違反やデータ漏洩のリスクを軽減できます。

OSV の詳細は、OSV Web サイト を参照してください。

3.2. OpenShift Container Platform の Clair

OpenShift Container Platform 上の Red Hat Quay デプロイメントで Clair v4 (Clair) をセットアップするには、Red Hat Quay Operator を使用することが推奨されます。デフォルトでは、Red Hat Quay Operator は、Clair デプロイメントを Red Hat Quay デプロイメントとともにインストールまたはアップグレードし、Clair を自動的に設定します。

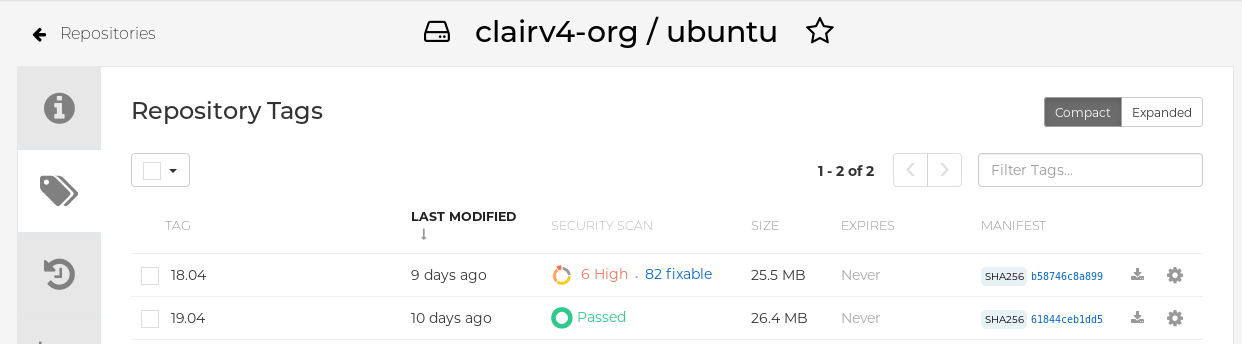

3.3. Clair のテスト

以下の手順を使用して、スタンドアロンの Red Hat Quay デプロイメントまたは OpenShift Container Platform Operator ベースのデプロイメントで Clair をテストします。

前提条件

- Clair コンテナーイメージをデプロイしている。

手順

次のコマンドを入力して、サンプルイメージをプルします。

podman pull ubuntu:20.04

$ podman pull ubuntu:20.04Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、レジストリーにイメージをタグ付けします。

sudo podman tag docker.io/library/ubuntu:20.04 <quay-server.example.com>/<user-name>/ubuntu:20.04

$ sudo podman tag docker.io/library/ubuntu:20.04 <quay-server.example.com>/<user-name>/ubuntu:20.04Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを入力して、イメージを Red Hat Quay レジストリーにプッシュします。

sudo podman push --tls-verify=false quay-server.example.com/quayadmin/ubuntu:20.04

$ sudo podman push --tls-verify=false quay-server.example.com/quayadmin/ubuntu:20.04Copy to Clipboard Copied! Toggle word wrap Toggle overflow - UI から Red Hat Quay デプロイメントにログインします。

- リポジトリー名 (quayadmin/ubuntu など) をクリックします。

ナビゲーションウィンドウで、Tags をクリックします。

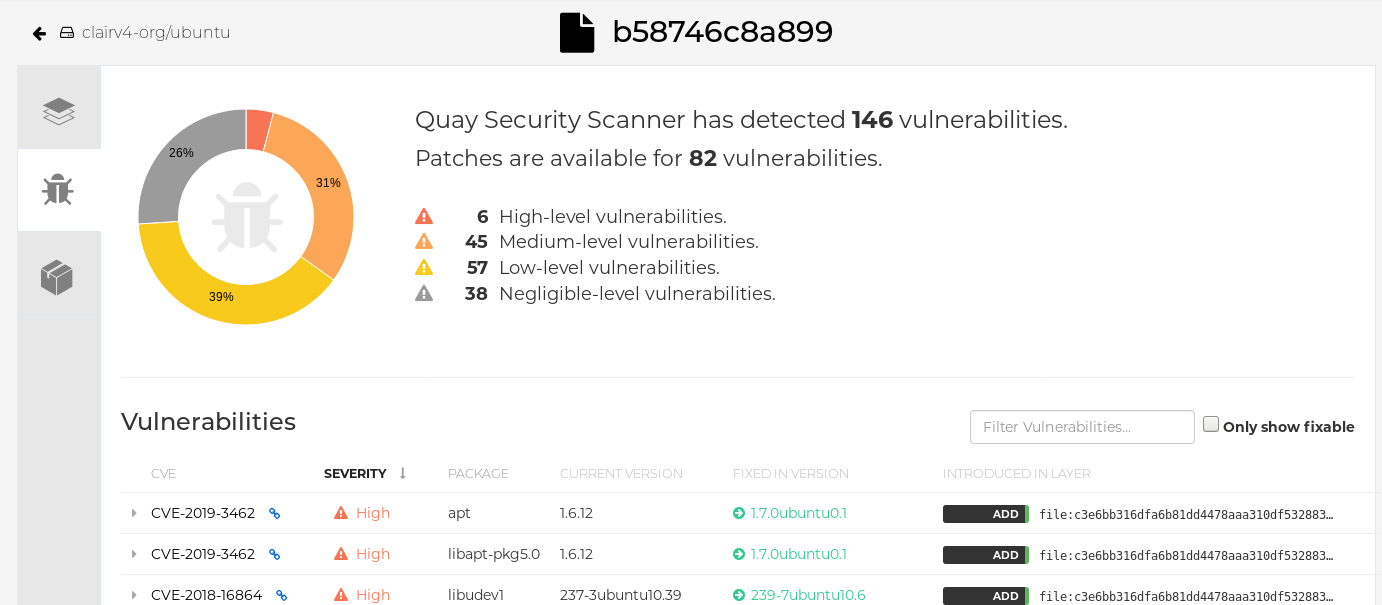

レポートの概要

イメージレポート (例: 45 medium) をクリックして、より詳細なレポートを表示します。

レポートの詳細

注記

注記場合によっては、Clair はイメージに関する重複レポートを表示します (例:

ubi8/nodejs-12またはubi8/nodejs-16)。これは、同じ名前の脆弱性が異なるパッケージに存在するために発生します。この動作は Clair 脆弱性レポートで予期されており、バグとしては扱われません。

3.4. 高度な Clair 設定

次のセクションの手順を使用して、Clair の詳細設定を行います。

3.4.1. アンマネージド Clair 設定

Red Hat Quay ユーザーは、Red Hat Quay OpenShift Container Platform Operator を使用してアンマネージド Clair 設定を実行できます。この機能により、ユーザーはアンマネージド Clair データベースを作成したり、アンマネージドデータベースなしでカスタム Clair 設定を実行したりできます。

アンマネージド Clair データベースにより、Red Hat Quay オペレーターは、Operator の複数のインスタンスが同じデータベースと通信する必要がある地理的に複製された環境で作業できます。アンマネージド Clair データベースは、ユーザーがクラスターの外部に存在する高可用性 (HA) Clair データベースを必要とする場合にも使用できます。

3.4.1.1. アンマネージド Clair データベースを使用したカスタム Clair 設定の実行

次の手順を使用して、Clair データベースをアンマネージドに設定します。

Red Hat Quay と Clair の両方のデプロイメントに、外部で管理される同じ PostgreSQL データベースを使用しないでください。また、Red Hat Quay や Clair などの接続集約型のワークロードがリソースを競合すると、PostgreSQL 側の自然な接続制限を使い果たしてしまう可能性があるため、PostgreSQL データベースを他のワークロードと共有しないでください。さらに、pgBouncer は Red Hat Quay または Clair ではサポートされていないため、この問題を解決するオプションではありません。

手順

Quay Operator で、

QuayRegistryカスタムリソースのclairpostgresコンポーネントをmanaged: falseに設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.1.2. アンマネージド Clair データベースを使用したカスタム Clair データベースの設定

Red Hat Quay on OpenShift Container Platform では、ユーザーが独自の Clair データベースを指定できます。

次の手順を使用して、カスタム Clair データベースを作成します。

次の手順では、SSL/TLS 証明書を使用して Clair をセットアップします。SSL/TLS 証明書を使用して Clair をセットアップしない同様の手順を表示するには、「マネージド Clair 設定を使用したカスタム Clair データベースの設定」を参照してください。

手順

次のコマンドを入力して、

clair-config.yamlを含む Quay 設定バンドルシークレットを作成します。oc create secret generic --from-file config.yaml=./config.yaml --from-file extra_ca_cert_rds-ca-2019-root.pem=./rds-ca-2019-root.pem --from-file clair-config.yaml=./clair-config.yaml --from-file ssl.cert=./ssl.cert --from-file ssl.key=./ssl.key config-bundle-secret

$ oc create secret generic --from-file config.yaml=./config.yaml --from-file extra_ca_cert_rds-ca-2019-root.pem=./rds-ca-2019-root.pem --from-file clair-config.yaml=./clair-config.yaml --from-file ssl.cert=./ssl.cert --from-file ssl.key=./ssl.key config-bundle-secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow Clair

config.yamlファイルの例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記-

データベース証明書は、

clair-config.yamlの Clair アプリケーション Pod の/run/certs/rds-ca-2019-root.pemの下にマウントされます。clair-config.yamlを設定するときに指定する必要があります。 -

clair-config.yamlの例は、OpenShift 設定の Clair にあります。

-

データベース証明書は、

clair-config.yamlファイルをバンドルシークレットに追加します。次に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記更新すると、提供された

clair-config.yamlファイルが Clair Pod にマウントされます。提供されていないフィールドには、Clair 設定モジュールを使用してデフォルトが自動的に入力されます。Build History ページでコミットをクリックするか、

oc get pods -n <namespace>を実行して、Clair Pod のステータスを確認できます。以下に例を示します。oc get pods -n <namespace>

$ oc get pods -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME READY STATUS RESTARTS AGE f192fe4a-c802-4275-bcce-d2031e635126-9l2b5-25lg2 1/1 Running 0 7s

NAME READY STATUS RESTARTS AGE f192fe4a-c802-4275-bcce-d2031e635126-9l2b5-25lg2 1/1 Running 0 7sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.2. マネージド Clair データベースを使用したカスタム Clair 設定の実行

場合によっては、マネージド Clair データベースを使用してカスタム Clair 設定を実行します。これは、以下のシナリオで役に立ちます。

- ユーザーが特定のアップデーターリソースを無効にする場合。

ユーザーが非接続環境で Red Hat Quay を実行している場合。非接続環境での Clair の実行の詳細は、非接続環境での Clair を参照してください。

注記-

Red Hat Quay を非接続環境で実行している場合は、

Clair-config.yamlのairgapパラメーターをTrueに設定する必要があります。 - 非接続環境で Red Hat Quay を実行している場合は、すべてのアップデーターコンポーネントを無効にする必要があります。

-

Red Hat Quay を非接続環境で実行している場合は、

3.4.2.1. Clair データベースをマネージドに設定する

次の手順を使用して、Clair データベースをマネージドに設定します。

手順

Quay Operator で、

QuayRegistryカスタムリソースのclairpostgresコンポーネントをmanaged: trueに設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.2.2. マネージド Clair 設定を使用したカスタム Clair データベースの設定

Red Hat Quay on OpenShift Container Platform では、ユーザーが独自の Clair データベースを指定できます。

次の手順を使用して、カスタム Clair データベースを作成します。

手順

次のコマンドを入力して、

clair-config.yamlを含む Quay 設定バンドルシークレットを作成します。oc create secret generic --from-file config.yaml=./config.yaml --from-file extra_ca_cert_rds-ca-2019-root.pem=./rds-ca-2019-root.pem --from-file clair-config.yaml=./clair-config.yaml config-bundle-secret

$ oc create secret generic --from-file config.yaml=./config.yaml --from-file extra_ca_cert_rds-ca-2019-root.pem=./rds-ca-2019-root.pem --from-file clair-config.yaml=./clair-config.yaml config-bundle-secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow Clair

config.yamlファイルの例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記-

データベース証明書は、

clair-config.yamlの Clair アプリケーション Pod の/run/certs/rds-ca-2019-root.pemの下にマウントされます。clair-config.yamlを設定するときに指定する必要があります。 -

clair-config.yamlの例は、OpenShift 設定の Clair にあります。

-

データベース証明書は、

clair-config.yamlファイルをバンドルシークレットに追加します。次に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記-

更新すると、提供された

clair-config.yamlファイルが Clair Pod にマウントされます。提供されていないフィールドには、Clair 設定モジュールを使用してデフォルトが自動的に入力されます。

-

更新すると、提供された

Build History ページでコミットをクリックするか、

oc get pods -n <namespace>を実行して、Clair Pod のステータスを確認できます。以下に例を示します。oc get pods -n <namespace>

$ oc get pods -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME READY STATUS RESTARTS AGE f192fe4a-c802-4275-bcce-d2031e635126-9l2b5-25lg2 1/1 Running 0 7s

NAME READY STATUS RESTARTS AGE f192fe4a-c802-4275-bcce-d2031e635126-9l2b5-25lg2 1/1 Running 0 7sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.3. 切断された環境での Clair

Clair は、updater と呼ばれる一連のコンポーネントを使用して、さまざまな脆弱性データベースからのデータのフェッチと解析を処理します。updater はデフォルトで、脆弱性データをインターネットから直接プルし、すぐに使用できるように設定されています。ただし、ユーザーによっては、Red Hat Quay を非接続環境、またはインターネットに直接アクセスできない環境で実行する必要がある場合があります。Clair は、ネットワーク分離を考慮したさまざまな種類の更新ワークフローを使用することで、非接続環境をサポートします。これは clairctl コマンドラインインターフェイスツールを使用して機能します。このツールは、オープンホストを使用してインターネットから updater データを取得し、そのデータを隔離されたホストにセキュアに転送してから、隔離されたホスト上の updater データを Clair にインポートします。

非接続環境で Clair をデプロイするには、このガイドを使用してください。

現在、Clair エンリッチメントデータは CVSS データです。エンリッチメントデータは現在、オフライン環境ではサポートされていません。

Clair アップデーターの詳細は、「Clair アップデーター」を参照してください。

3.4.3.1. 非接続の OpenShift Container Platform クラスターで Clair をセットアップする

以下の手順を使用して、切断された OpenShift Container Platform クラスターに OpenShift Container Platform でプロビジョニングされた Clair Pod をセットアップします。

3.4.3.1.1. OpenShift Container Platform デプロイメント用の clairctl コマンドラインユーティリティーツールのインストール

以下の手順を使用して、OpenShift Container Platform デプロイメント用の clairctl CLI ツールをインストールします。

手順

以下のコマンドを入力して、Clair デプロイメント用の

clairctlプログラムを OpenShift Container Platform クラスターにインストールします。oc -n quay-enterprise exec example-registry-clair-app-64dd48f866-6ptgw -- cat /usr/bin/clairctl > clairctl

$ oc -n quay-enterprise exec example-registry-clair-app-64dd48f866-6ptgw -- cat /usr/bin/clairctl > clairctlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記非公式ですが、

clairctlツールをダウンロードできます。clairctlファイルの権限を設定して、ユーザーが実行できるようにします。次に例を示します。chmod u+x ./clairctl

$ chmod u+x ./clairctlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.3.1.2. OpenShift Container Platform での Clair デプロイメントの Clair 設定シークレットの取得とデコード

以下の手順を使用して、OpenShift Container Platform 上の OpenShift Container Platform でプロビジョニングされた Clair インスタンスの設定シークレットを取得してデコードします。

前提条件

-

clairctlコマンドラインユーティリティーツールをインストールしている。

手順

次のコマンドを入力して、設定シークレットを取得してデコードし、それを Clair 設定 YAML に保存します。

oc get secret -n quay-enterprise example-registry-clair-config-secret -o "jsonpath={$.data['config\.yaml']}" | base64 -d > clair-config.yaml$ oc get secret -n quay-enterprise example-registry-clair-config-secret -o "jsonpath={$.data['config\.yaml']}" | base64 -d > clair-config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Clair-config.yamlファイルを更新して、disable_updatersおよびairgapパラメーターがTrueに設定されます。例:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.3.1.3. 接続された Clair インスタンスからアップデータバンドルをエクスポートする

次の手順を使用して、インターネットにアクセスできる Clair インスタンスから更新プログラムバンドルをエクスポートします。

前提条件

-

clairctlコマンドラインユーティリティーツールをインストールしている。 -

Clair 設定シークレットを取得してデコードし、Clair の

config.yamlファイルに保存している。 -

Clair

config.yamlファイルで、disable_updatersおよびairgapパラメーターがTrueに設定されています。

手順

インターネットにアクセスできる Clair インスタンスから、設定ファイルで

clairctlCLI ツールを使用して、アップデーターバンドルをエクスポートします。以下に例を示します。./clairctl --config ./config.yaml export-updaters updates.gz

$ ./clairctl --config ./config.yaml export-updaters updates.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.3.1.4. 非接続の OpenShift Container Platform クラスター内の Clair データベースへのアクセスの設定

以下の手順を使用して、非接続の OpenShift Container Platform クラスター内の Clair データベースへのアクセスを設定します。

前提条件

-

clairctlコマンドラインユーティリティーツールをインストールしている。 -

Clair 設定シークレットを取得してデコードし、Clair の

config.yamlファイルに保存している。 -

Clair

config.yamlファイルで、disable_updatersおよびairgapパラメーターがTrueに設定されています。 - インターネットにアクセスできる Clair インスタンスからアップデーターバンドルをエクスポートしている。

手順

CLI ツール

ocを使用して、Clair データベースサービスを特定します。次に例を示します。oc get svc -n quay-enterprise

$ oc get svc -n quay-enterpriseCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE example-registry-clair-app ClusterIP 172.30.224.93 <none> 80/TCP,8089/TCP 4d21h example-registry-clair-postgres ClusterIP 172.30.246.88 <none> 5432/TCP 4d21h ...

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE example-registry-clair-app ClusterIP 172.30.224.93 <none> 80/TCP,8089/TCP 4d21h example-registry-clair-postgres ClusterIP 172.30.246.88 <none> 5432/TCP 4d21h ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow Clair データベースポートを転送して、ローカルマシンからアクセスできるようにします。以下に例を示します。

oc port-forward -n quay-enterprise service/example-registry-clair-postgres 5432:5432

$ oc port-forward -n quay-enterprise service/example-registry-clair-postgres 5432:5432Copy to Clipboard Copied! Toggle word wrap Toggle overflow Clair の

config.yamlファイルを更新します。次に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.3.1.5. 非接続の OpenShift Container Platform クラスターへのアップデーターバンドルのインポート

以下の手順を使用して、アップデーターバンドルを非接続の OpenShift Container Platform クラスターにインポートします。

前提条件

-

clairctlコマンドラインユーティリティーツールをインストールしている。 -

Clair 設定シークレットを取得してデコードし、Clair の

config.yamlファイルに保存している。 -

Clair

config.yamlファイルで、disable_updatersおよびairgapパラメーターがTrueに設定されています。 - インターネットにアクセスできる Clair インスタンスからアップデーターバンドルをエクスポートしている。

- アップデーターバンドルを非接続環境に転送している。

手順

CLI ツール

clairctlを使用して、アップデーターバンドルを OpenShift Container Platform によってデプロイされた Clair データベースにインポートします。以下に例を示します。./clairctl --config ./clair-config.yaml import-updaters updates.gz

$ ./clairctl --config ./clair-config.yaml import-updaters updates.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.3.2. 非接続の OpenShift Container Platform クラスター用の Clair の自己管理デプロイメントをセットアップする

以下の手順を使用して、切断された OpenShift Container Platform クラスター用に Clair の自己管理デプロイメントをセットアップします。

3.4.3.2.1. OpenShift Container Platform で自己管理 Clair デプロイメント用の clairctl コマンドラインユーティリティーツールをインストールする

以下の手順を使用して、OpenShift Container Platform に自己管理 Clair デプロイメント用の clairctl CLI ツールをインストールします。

手順

podman cpコマンドを使用して、自己管理の Clair デプロイメント用のclairctlプログラムをインストールします。以下に例を示します。sudo podman cp clairv4:/usr/bin/clairctl ./clairctl

$ sudo podman cp clairv4:/usr/bin/clairctl ./clairctlCopy to Clipboard Copied! Toggle word wrap Toggle overflow clairctlファイルの権限を設定して、ユーザーが実行できるようにします。次に例を示します。chmod u+x ./clairctl

$ chmod u+x ./clairctlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.3.2.2. 非接続の OpenShift Container Platform クラスター用の自己管理 Clair コンテナーをデプロイする

以下の手順を使用して、非接続の OpenShift Container Platform クラスター用の自己管理 Clair コンテナーをデプロイします。

前提条件

-

clairctlコマンドラインユーティリティーツールをインストールしている。

手順

Clair 設定ファイル用のフォルダーを作成します。次に例を示します。

mkdir /etc/clairv4/config/

$ mkdir /etc/clairv4/config/Copy to Clipboard Copied! Toggle word wrap Toggle overflow Clair 設定ファイルを作成し、

disable_updatersパラメーターをTrueに設定します。例:Copy to Clipboard Copied! Toggle word wrap Toggle overflow コンテナーイメージを使用して Clair を起動し、作成したファイルから設定にマウントします。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.3.2.3. 接続された Clair インスタンスからアップデータバンドルをエクスポートする

次の手順を使用して、インターネットにアクセスできる Clair インスタンスから更新プログラムバンドルをエクスポートします。

前提条件

-

clairctlコマンドラインユーティリティーツールをインストールしている。 - Clair をデプロイしている。

-

Clair

config.yamlファイルで、disable_updatersおよびairgapパラメーターがTrueに設定されています。

手順

インターネットにアクセスできる Clair インスタンスから、設定ファイルで

clairctlCLI ツールを使用して、アップデーターバンドルをエクスポートします。以下に例を示します。./clairctl --config ./config.yaml export-updaters updates.gz

$ ./clairctl --config ./config.yaml export-updaters updates.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.3.2.4. 非接続の OpenShift Container Platform クラスター内の Clair データベースへのアクセスの設定

以下の手順を使用して、非接続の OpenShift Container Platform クラスター内の Clair データベースへのアクセスを設定します。

前提条件

-

clairctlコマンドラインユーティリティーツールをインストールしている。 - Clair をデプロイしている。

-

Clair

config.yamlファイルで、disable_updatersおよびairgapパラメーターがTrueに設定されています。 - インターネットにアクセスできる Clair インスタンスからアップデーターバンドルをエクスポートしている。

手順

CLI ツール

ocを使用して、Clair データベースサービスを特定します。次に例を示します。oc get svc -n quay-enterprise

$ oc get svc -n quay-enterpriseCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE example-registry-clair-app ClusterIP 172.30.224.93 <none> 80/TCP,8089/TCP 4d21h example-registry-clair-postgres ClusterIP 172.30.246.88 <none> 5432/TCP 4d21h ...

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE example-registry-clair-app ClusterIP 172.30.224.93 <none> 80/TCP,8089/TCP 4d21h example-registry-clair-postgres ClusterIP 172.30.246.88 <none> 5432/TCP 4d21h ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow Clair データベースポートを転送して、ローカルマシンからアクセスできるようにします。以下に例を示します。

oc port-forward -n quay-enterprise service/example-registry-clair-postgres 5432:5432

$ oc port-forward -n quay-enterprise service/example-registry-clair-postgres 5432:5432Copy to Clipboard Copied! Toggle word wrap Toggle overflow Clair の

config.yamlファイルを更新します。次に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.3.2.5. 非接続の OpenShift Container Platform クラスターへのアップデーターバンドルのインポート

以下の手順を使用して、アップデーターバンドルを非接続の OpenShift Container Platform クラスターにインポートします。

前提条件

-

clairctlコマンドラインユーティリティーツールをインストールしている。 - Clair をデプロイしている。

-

Clair

config.yamlファイルで、disable_updatersおよびairgapパラメーターがTrueに設定されています。 - インターネットにアクセスできる Clair インスタンスからアップデーターバンドルをエクスポートしている。

- アップデーターバンドルを非接続環境に転送している。

手順

CLI ツール

clairctlを使用して、アップデーターバンドルを OpenShift Container Platform によってデプロイされた Clair データベースにインポートします。./clairctl --config ./clair-config.yaml import-updaters updates.gz

$ ./clairctl --config ./clair-config.yaml import-updaters updates.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.4. Common Product Enumeration へのリポジトリーのマッピング

Clair の Red Hat Enterprise Linux (RHEL) スキャナーは、Common Product Enumeration (CPE) ファイルに依存して、RPM パッケージを対応するセキュリティーデータにマッピングし、マッチングする結果を生成します。Red Hat Product Security はこれらのファイルを管理し、定期的に更新します。

スキャナーが RPM を適切に処理するには、CPE ファイルが存在するか、ファイルへのアクセスが許可されている必要があります。ファイルが存在しないと、コンテナーイメージにインストールされている RPM パッケージはスキャンされません。

| CPE | JSON マッピングファイルへのリンク |

|---|---|

|

| |

|

|

デフォルトでは、Clair のインデクサーには、Clair コンテナー内に repos2cpe および names2repos データファイルが含まれます。これは、追加の設定を必要とせずに、clair-config.yaml ファイルの /data/repository-to-cpe.json および /data/container-name-repos-map.json を参照できます。

Red Hat Product Security は repos2cpe ファイルと names2repos ファイルを定期的に更新しますが、Clair コンテナーに含まれるバージョンは Red Hat Quay リリースでのみ更新されます (例: バージョン 3.14.1 → 3.14.2)。これにより、最新の CPE ファイルと Clair にバンドルされているファイルとの間で不一致が生じる可能性があります。

3.4.4.1. Common Product Enumeration サンプル設定へのリポジトリーのマッピング

Clair 設定の repo2cpe_mapping_file フィールドと name2repos_mapping_file フィールドを使用して、CPE JSON マッピングファイルを含めます。以下に例を示します。

詳細は、OVAL セキュリティーデータをインストール済みの RPM と正確にマッチングする方法 を参照してください。

第4章 インフラストラクチャーノードへの Red Hat Quay のデプロイ

デフォルトでは、Red Hat Quay Operator を使用してレジストリーをデプロイする際に Quay 関連の Pod は任意のワーカーノードに配置されます。マシンセットを使用してインフラストラクチャーコンポーネントのみをホストするようにノードを設定する方法の詳細は、インフラストラクチャーマシンセットの作成 を参照してください。

OpenShift Container Platform マシンセットリソースを使用してインフラノードをデプロイしていない場合、このドキュメントのセクションでは、インフラストラクチャー目的でノードに手動でラベルを付けてテイントする方法を示します。手動またはマシンセットを使用してインフラストラクチャーノードを設定したら、ノードセレクターおよび容認を使用してこれらのノードに対する Quay Pod の配置を制御できます。

4.1. インフラストラクチャー用ノードへのラベルとテインとの追加

次の手順を実行して、インフラストラクチャー用のノードにラベルと taint を追加します。

次のコマンドを入力して、マスターノードとワーカーノードを表示します。この例では、3 つのマスターノードと 6 つのワーカーノードがあります。

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、インフラストラクチャーで使用する 3 つのワーカーノードにラベルを付けます。

oc label node --overwrite user1-jcnp6-worker-c-pwxfp.c.quay-devel.internal node-role.kubernetes.io/infra=

$ oc label node --overwrite user1-jcnp6-worker-c-pwxfp.c.quay-devel.internal node-role.kubernetes.io/infra=Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc label node --overwrite user1-jcnp6-worker-d-h5tv2.c.quay-devel.internal node-role.kubernetes.io/infra=

$ oc label node --overwrite user1-jcnp6-worker-d-h5tv2.c.quay-devel.internal node-role.kubernetes.io/infra=Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc label node --overwrite user1-jcnp6-worker-d-m9gg4.c.quay-devel.internal node-role.kubernetes.io/infra=

$ oc label node --overwrite user1-jcnp6-worker-d-m9gg4.c.quay-devel.internal node-role.kubernetes.io/infra=Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここで、クラスター内のノードをリストすると、最後の 3 つのワーカーノードには

infraロールが与えられます。以下に例を示します。oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ワーカーノードに

infraロールが割り当てられている場合、ユーザーのワークロードが誤ってインフラノードに割り当てられる可能性があります。これを回避するには、infra ノードにテイントを適用し、制御する Pod に容認を追加します。以下に例を示します。oc adm taint nodes user1-jcnp6-worker-c-pwxfp.c.quay-devel.internal node-role.kubernetes.io/infra:NoSchedule

$ oc adm taint nodes user1-jcnp6-worker-c-pwxfp.c.quay-devel.internal node-role.kubernetes.io/infra:NoScheduleCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc adm taint nodes user1-jcnp6-worker-d-h5tv2.c.quay-devel.internal node-role.kubernetes.io/infra:NoSchedule

$ oc adm taint nodes user1-jcnp6-worker-d-h5tv2.c.quay-devel.internal node-role.kubernetes.io/infra:NoScheduleCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc adm taint nodes user1-jcnp6-worker-d-m9gg4.c.quay-devel.internal node-role.kubernetes.io/infra:NoSchedule

$ oc adm taint nodes user1-jcnp6-worker-d-m9gg4.c.quay-devel.internal node-role.kubernetes.io/infra:NoScheduleCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2. ノードセレクターと容認を使用したプロジェクト作成

ノードセレクターと容認を持つプロジェクトを作成するには、次の手順を実行します。

次の手順は、インストールされている Red Hat Quay Operator と、デプロイメントの作成時に使用した namespace を削除することによっても完了できます。その後、次のアノテーションを付けて新しいリソースを作成できます。

手順

次のコマンドを入力して、Red Hat Quay がデプロイされている namespace と次のアノテーションを編集します。

oc annotate namespace <namespace> openshift.io/node-selector='node-role.kubernetes.io/infra='

$ oc annotate namespace <namespace> openshift.io/node-selector='node-role.kubernetes.io/infra='Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

namespace/<namespace> annotated

namespace/<namespace> annotatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、使用可能な Pod のリストを取得します。

oc get pods -o wide

$ oc get pods -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、使用可能な Pod を削除します。

oc delete pods --selector quay-operator/quayregistry=example-registry -n quay-enterprise

$ oc delete pods --selector quay-operator/quayregistry=example-registry -n quay-enterpriseCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Pod を削除すると、Pod は自動的に再稼働し、専用のインフラストラクチャーノードでスケジュールされます。

4.3. Red Hat Quay on OpenShift Container Platform を特定の namespace にインストールする

以下の手順を使用して、Red Hat Quay on OpenShift Container Platform を特定の namespace にインストールします。

Red Hat Quay Operator を特定の namespace にインストールするには、次のコマンドのように、適切なプロジェクト namespace を明示的に指定する必要があります。

次の例では、

quay-registrynamespace を使用します。これにより、quay-operatorPod が 3 つのインフラストラクチャーノードのいずれかに配置されます。以下に例を示します。oc get pods -n quay-registry -o wide

$ oc get pods -n quay-registry -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME READY STATUS RESTARTS AGE IP NODE quay-operator.v3.4.1-6f6597d8d8-bd4dp 1/1 Running 0 30s 10.131.0.16 user1-jcnp6-worker-d-h5tv2.c.quay-devel.internal

NAME READY STATUS RESTARTS AGE IP NODE quay-operator.v3.4.1-6f6597d8d8-bd4dp 1/1 Running 0 30s 10.131.0.16 user1-jcnp6-worker-d-h5tv2.c.quay-devel.internalCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4. Red Hat Quay レジストリーの作成

Red Hat Quay レジストリーを作成するには、次の手順を実行します。

次のコマンドを入力して、Red Hat Quay レジストリーを作成します。次に、デプロイメントが

readyとしてマークされるまで待ちます。次の例では、インフラストラクチャー目的でラベルを付けた 3 つのノード上でのみスケジュールされていることがわかります。oc get pods -n quay-registry -o wide

$ oc get pods -n quay-registry -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5. 管理ストレージのサイズ変更

OpenShift Container Platform に Red Hat Quay をデプロイすると、次の 3 つの異なる永続ボリューム要求 (PVC) がデプロイされます。

- PostgreSQL 13 レジストリー用の PVC

- Clair PostgreSQL 13 レジストリー用の PVC

- NooBaa をバックエンドストレージとして使用する PVC

Red Hat Quay と NooBaa の間の接続は、OpenShift Container Platform の S3 API および ObjectBucketClaim API を通じて行われます。Red Hat Quay は、その API グループを利用して NooBaa にバケットを作成し、アクセスキーを取得して、すべてを自動的にセットアップします。バックエンド (NooBaa) 側では、そのバケットはバッキングストア内に作成されます。そのため、NooBaa PVC は Red Hat Quay Pod にマウントまたは接続されません。

PostgreSQL 13 の PVC および Clair PostgreSQL 13 の PVC のデフォルトサイズは 50 GiB に設定されています。以下の手順を使用して、OpenShift Container Platform コンソールでこれらの PVC のストレージを拡張できます。

次の手順は、Red Hat OpenShift Data Foundation での 永続ボリューム要求の拡張 と共通しています。

4.5.1. Red Hat Quay の PostgreSQL 13 PVC のサイズ変更

PostgreSQL 13 の PVC および Clair PostgreSQL 13 の PVC のサイズを変更するには、次の手順を使用します。

前提条件

- OpenShift Container Platform のクラスター管理者権限がある。

手順

- OpenShift Container Platform コンソールにログインし、Storage → Persistent Volume Claims を選択します。

-

PostgreSQL 13 または Clair PostgreSQL 13 に必要な

PersistentVolumeClaimを選択します (例:example-registry-quay-postgres-13)。 - Action メニューから Expand PVC を選択します。

永続ボリューム要求の新しいサイズを入力し、Expand を選択します。

数分後、拡張されたサイズが PVC の Capacity フィールドに反映されます。

4.6. デフォルトの Operator イメージのカスタマイズ

現在、デフォルトの Operator イメージのカスタマイズは、IBM Power および IBM Z ではサポートされていません。

特定の状況では、Red Hat Quay Operator が使用するデフォルトのイメージをオーバーライドすると便利な場合があります。これを行うには、Red Hat Quay Operator ClusterServiceVersion で 1 つ以上の環境変数を設定します。

このメカニズムの使用は、実稼働 Red Hat Quay 環境ではサポートされておらず、開発またはテストの目的でのみ使用することが強く推奨されます。Red Hat Quay Operator でデフォルト以外のイメージを使用する場合は、デプロイメントが正しく機能するという保証はありません。

4.6.1. 環境変数

以下の環境変数は、Red Hat Quay Operator でコンポーネントイメージをオーバーライドするために使用されます。

| 環境変数 | コンポーネント |

|

|

|

|

|

|

|

|

|

|

|

|

オーバーライドされたイメージは、タグ (:latest) ではなく、マニフェスト (@sha256:) によって参照する 必要があります。

4.6.2. 実行中のオペレータへのオーバーライドの適用

Red Hat Quay Operator が Operator Lifecycle Manager (OLM) を通じてクラスターにインストールされている場合、マネージドコンポーネントのコンテナーイメージは、ClusterServiceVersion オブジェクトを変更すると簡単にオーバーライドできます。

以下の手順を使用して、実行中の Red Hat Quay Operator にオーバーライドを適用します。

手順

ClusterServiceVersionオブジェクトは、クラスター内で実行中の Operator を Operator Lifecycle Manager が表現したものです。Kubernetes UI またはkubectl/ocCLI ツールを使用して、Red Hat Quay Operator のClusterServiceVersionを見つけます。以下に例を示します。oc get clusterserviceversions -n <your-namespace>

$ oc get clusterserviceversions -n <your-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow UI、

oc edit、または別の方法を使用して、Red Hat QuayClusterServiceVersionを変更して、オーバーライドイメージを指す上記の環境変数を含めます。JSONPath:

spec.install.spec.deployments[0].spec.template.spec.containers[0].envCopy to Clipboard Copied! Toggle word wrap Toggle overflow

これは Operator レベルで実行されるため、すべての QuayRegistry はこれらの同じオーバーライドを使用してデプロイされています。

4.7. AWS S3 CloudFront

バックエンドレジストリーストレージに AWS S3 Cloudfront を使用している場合は、次の手順を使用します。

手順

次のコマンドを入力してレジストリーキーを指定します。

oc create secret generic --from-file config.yaml=./config_awss3cloudfront.yaml --from-file default-cloudfront-signing-key.pem=./default-cloudfront-signing-key.pem test-config-bundle

$ oc create secret generic --from-file config.yaml=./config_awss3cloudfront.yaml --from-file default-cloudfront-signing-key.pem=./default-cloudfront-signing-key.pem test-config-bundleCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第5章 Red Hat Quay on OpenShift Container Platform を使用した仮想ビルド

ビルド 機能に関するドキュメントは 、ビルダーとイメージ自動化 に移動されました。この章は、Red Hat Quay の今後のバージョンでは削除される予定です。

第6章 Geo レプリケーション

Geo レプリケーションでは、地理的に分散した複数の Red Hat Quay デプロイメントを、クライアントやユーザーの視点から、単一のレジストリーとして動作させることができます。グローバルに分散された Red Hat Quay のセットアップにおいて、プッシュとプルのパフォーマンスが大幅に向上します。イメージデータはバックグラウンドで非同期的に複製され、クライアントには透過的なフェイルオーバー/リダイレクトが行われます。

Geo レプリケーションを使用した Red Hat Quay のデプロイメントは、スタンドアロンおよび Operator デプロイメントでサポートされます。

関連情報

- ジオレプリケーション機能のアーキテクチャーの詳細は、技術図と概要が記載されている アーキテクチャーガイド を参照してください。

6.1. Geo レプリケーション機能

- Geo レプリケーションが設定されると、コンテナーイメージのプッシュはその Red Hat Quay インスタンスの優先ストレージエンジンに書き込まれます。これは通常、リージョン内で最も近いストレージバックエンドです。

- 最初のプッシュの後、イメージデータはバックグランドで他のストレージエンジンに複製されます。

- レプリケーションロケーションのリストは設定可能で、それらは異なるストレージバックエンドにできます。

- イメージプルでは、プルのパフォーマンスを最大化するために、常に利用可能な最も近いストレージエンジンを使用します。

- レプリケーションがまだ完了していない場合、プルでは代わりにソースストレージバックエンドが使用されます。

6.2. Geo レプリケーションの要件と制約

- Geo レプリケーション設定では、Red Hat Quay で、すべてのリージョンが他の全リージョンのオブジェクトストレージに対して読み取りと書き込みができるようにする必要があります。オブジェクトストレージは、他のすべてのリージョンから地理的にアクセスできる必要があります。

- 1 つの Geo レプリケーションサイトでオブジェクトストレージシステムに障害が発生した場合に、そのサイトの Red Hat Quay デプロイメントをシャットダウンして、クライアントがグローバルロードバランサーにより、ストレージシステムで問題のない残りのサイトにリダイレクトされるようにする必要があります。そうしないと、クライアントでプルとプッシュの失敗が発生します。

- Red Hat Quay は、接続されたオブジェクトストレージシステムの健全性や可用性を内部的に認識しません。分散システムの健全性を監視し、ストレージのステータスに基づいてトラフィックを別のサイトにルーティングするには、ユーザーがグローバルロードバランサー (LB) を設定する必要があります。

-

Geo レプリケーションデプロイメントのステータスを確認するには、

/health/endtoendチェックポイントを使用する必要があります。このチェックポイントは全体的な健全性の監視に使用されます。/health/endtoendエンドポイントを使用してリダイレクトを手動で設定する必要があります。/health/instanceエンドポイントは、ローカルインスタンスの健全性のみをチェックします。 - 1 つのサイトのオブジェクトストレージシステムが利用できなくなった場合に、残りのサイトの残りのストレージシステム (複数可) に自動的にリダイレクトされません。

- Geo レプリケーションは非同期です。サイトが完全に失われると、そのサイトのオブジェクトストレージシステムに保存されていても、障害発生時に残りのサイトに複製されていないデータが失われます。

単一のデータベース、つまりすべてのメタデータと Red Hat Quay 設定がすべてのリージョンで共有されます。

Geo レプリケーションはデータベースをレプリケートしません。障害が発生すると、Geo レプリケーションが有効になっている Red Hat Quay は別のデータベースにフェイルオーバーしません。

- 1 つの Redis キャッシュは Red Hat Quay のセットアップ全体で共有され、すべての Red Hat Quay Pod からアクセスできる必要があります。

-

ストレージバックエンド以外のすべてのリージョンで同じ設定を使用する必要があります。これは、

QUAY_DISTRIBUTED_STORAGE_PREFERENCE環境変数を使用して明示的に設定できます。 - Geo レプリケーションでは、各リージョンにオブジェクトストレージが必要です。ローカルストレージでは機能しません。

- 各リージョンは、ネットワークパスを必要とする各リージョン内のすべてのストレージエンジンにアクセスできる必要があります。

- また、ストレージプロキシーオプションを使用することもできます。

- ストレージバックエンド全体 (たとえば、すべての Blob) がレプリケートされます。対照的に、リポジトリーミラーリングはリポジトリーまたはイメージに限定できます。

- すべての Red Hat Quay インスタンスは、通常はロードバランサーを介して同じエントリーポイントを共有する必要があります。

- すべての Red Hat Quay インスタンスは、共通の設定ファイル内で定義されているため、スーパーユーザーの同じセットが含まれる必要があります。

geo レプリケーション環境では、Clair 設定を

unmanagedに設定できます。アンマネージド Clair データベースにより、Red Hat Quay オペレーターは、Operator の複数のインスタンスが同じデータベースと通信する必要がある地理的に複製された環境で作業できます。詳細は、Clair の高度な設定 を参照してください。Clair 設定を

managedのままにする場合は、Operator によってデプロイされた Clair インスタンスの設定ファイルを取得する必要があります。詳細は、OpenShift Container Platform での Clair デプロイメントの Clair 設定シークレットの取得とデコード を参照してください。- Geo レプリケーションには SSL/TLS 証明書とキーが必要です。詳細は、「Geo-Replication には SSL/TLS 証明書とキーが必要」を参照してください。詳細は、SSL/TLS 証明書を使用した概念実証のデプロイメント を参照してください。

上記の要件を満たすことができない場合は、代わりに 2 つ以上の異なる Red Hat Quay のデプロイメントを使用し、リポジトリーミラーリング機能を利用する必要があります。

6.2.1. OpenShift Container Platform での Geo レプリケーションのセットアップ

OpenShift Container Platform で Geo レプリケーションを設定するには、次の手順を実行します。

手順

- Red Hat Quay の postgres インスタンスをデプロイします。

次のコマンドを入力してデータベースにログインします。

psql -U <username> -h <hostname> -p <port> -d <database_name>

psql -U <username> -h <hostname> -p <port> -d <database_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow quayという名前で Red Hat Quay のデータベースを作成します。以下に例を示します。CREATE DATABASE quay;

CREATE DATABASE quay;Copy to Clipboard Copied! Toggle word wrap Toggle overflow データベース内で pg_trm 拡張機能を有効にします。

\c quay; CREATE EXTENSION IF NOT EXISTS pg_trgm;

\c quay; CREATE EXTENSION IF NOT EXISTS pg_trgm;Copy to Clipboard Copied! Toggle word wrap Toggle overflow Redis インスタンスをデプロイします。

注記- クラウドプロバイダーに独自のサービスが含まれている場合は、Redis インスタンスをデプロイする必要がない可能性があります。

- Builder を利用している場合は、Redis インスタンスをデプロイする必要があります。

- Redis 用の VM をデプロイします。

- Red Hat Quay が実行されているクラスターからアクセスできることを確認します。

- ポート 6379/TCP が開いている必要があります。

インスタンス内で Redis を実行します。

sudo dnf install -y podman podman run -d --name redis -p 6379:6379 redis

sudo dnf install -y podman podman run -d --name redis -p 6379:6379 redisCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- クラスターごとに 1 つずつ、2 つのオブジェクトストレージバックエンドを作成します。1 つのオブジェクトストレージバケットが最初のクラスター (プライマリークラスター) の近くにあり、もう 1 つが 2 番目のクラスター (セカンダリークラスター) の近くにあると理想的です。

- 環境変数のオーバーライドを使用して、同じ設定バンドルでクラスターをデプロイし、個々のクラスターに適切なストレージバックエンドを選択します。

- クラスターへの単一のエントリーポイントを提供するように、ロードバランサーを設定します。

6.2.1.1. Red Hat Quay on OpenShift Container Platform での geo レプリケーションの設定

Red Hat Quay on OpenShift Container Platform の geo レプリケーションを設定するには、次の手順を使用します。

手順

クラスター間で共有される

config.yamlファイルを作成します。このconfig.yamlファイルには、一般的な PostgreSQL、Redis、ストレージバックエンドの詳細が含まれています。Geo レプリケーションの

config.yamlファイルCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ルートには適切な

SERVER_HOSTNAMEを使用する必要があり、グローバルロードバランサーのホスト名と一致する必要があります。

次のコマンドを入力して、

configBundleSecretを作成します。oc create secret generic --from-file config.yaml=./config.yaml georep-config-bundle

$ oc create secret generic --from-file config.yaml=./config.yaml georep-config-bundleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 各クラスターで、

configBundleSecretを設定し、QUAY_DISTRIBUTED_STORAGE_PREFERENCE環境変数のオーバーライドを使用して、そのクラスターに適切なストレージを設定します。以下に例を示します。注記両方のデプロイメント間の

config.yamlファイルは一致する必要があります。一方のクラスターに変更を加える場合は、もう一方のクラスターでも変更する必要があります。US クラスター

QuayRegistryの例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記SSL/TLS が管理対象であり、ルートが管理対象外であるため、証明書を設定バンドルで直接指定する必要があります。詳細は、SSL/TLS とルートの設定を 参照してください。

ヨーロッパのクラスター

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記SSL/TLS が管理対象であり、ルートが管理対象外であるため、証明書を設定バンドルで直接指定する必要があります。詳細は、SSL/TLS とルートの設定を 参照してください。

6.2.2. Geo レプリケーションのための複合ストレージ

Red Hat Quay の Geo レプリケーションは、異なる複数のレプリケーションターゲットの使用をサポートしています。たとえば、パブリッククラウドの AWS S3 ストレージとオンプレミスの Ceph ストレージを使用します。これは、すべての Red Hat Quay Pod とクラスターノードからすべてのストレージバックエンドへのアクセスを許可するという重要な要件を複雑にします。そのため、以下を使用することを推奨します。

- 内部ストレージの可視性を防ぐための VPN、または

- Red Hat Quay が使用する特定のバケットへのアクセスのみを許可するトークンペア

これにより、Red Hat Quay のパブリッククラウドインスタンスがオンプレミスのストレージにアクセスできるようになりますが、ネットワークは暗号化され、保護され、ACL を使用するため、セキュリティー要件が満たされます。

これらのセキュリティー対策を実施できない場合は、2 つの異なる Red Hat Quay レジストリーをデプロイし、Geo レプリケーションの代わりにリポジトリーミラーリングを使用することが推奨されます。

6.3. Red Hat Quay on OpenShift Container Platform の geo レプリケーションデプロイメントのアップグレード

OpenShift Container Platform デプロイメント上の geo レプリケートされた Red Hat Quay をアップグレードするには、次の手順を使用します。

- OpenShift Container Platform デプロイメント上の geo レプリケートされた Red Hat Quay を次の y-stream リリース (例: Red Hat Quay 3.7 → Red Hat Quay 3.8) にアップグレードする場合は、アップグレードする前に操作を停止する必要があります。

- y-stream リリースを次のリリースにアップグレードする場合は、アップグレード中にダウンタイムが断続的に発生します。

- アップグレードする前に、Red Hat Quay on OpenShift Container Platform デプロイメントをバックアップすることを強く推奨します。

この手順は、3 つ以上のシステムで Red Hat Quay レジストリーを実行していることを前提としています。この手順では、System A、System B、および System C という名前の 3 つのシステムを想定します。System A は、Red Hat Quay Operator がデプロイされるプライマリーシステムとして機能します。

システム B およびシステム C で、Red Hat Quay レジストリーをスケールダウンします。これを行うには、自動スケーリングを無効にし、Red Hat Quay、ミラーワーカー、および Clair (マネージドの場合) のレプリカ数をオーバーライドします。次の

quayregistry.yamlファイルを参照として使用します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記Red Hat Quay レジストリーがシステム A で実行されている状態を維持する必要があります。システム A の

quayregistry.yamlファイルは更新しないでください。registry-quay-app、registry-quay-mirror、およびregistry-clair-appPod が消えるまで待機します。以下のコマンドを入力してステータスを確認します。oc get pods -n <quay-namespace>

oc get pods -n <quay-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

quay-operator.v3.7.1-6f9d859bd-p5ftc 1/1 Running 0 12m quayregistry-clair-postgres-7487f5bd86-xnxpr 1/1 Running 1 (12m ago) 12m quayregistry-quay-app-upgrade-xq2v6 0/1 Completed 0 12m quayregistry-quay-redis-84f888776f-hhgms 1/1 Running 0 12m

quay-operator.v3.7.1-6f9d859bd-p5ftc 1/1 Running 0 12m quayregistry-clair-postgres-7487f5bd86-xnxpr 1/1 Running 1 (12m ago) 12m quayregistry-quay-app-upgrade-xq2v6 0/1 Completed 0 12m quayregistry-quay-redis-84f888776f-hhgms 1/1 Running 0 12mCopy to Clipboard Copied! Toggle word wrap Toggle overflow - システム A で、最新の y-stream バージョンへの Red Hat Quay のアップグレードを開始します。これは手動プロセスです。インストールされた Operator のアップグレードの詳細は、インストールされた Operator のアップグレード を参照してください。Red Hat Quay のアップグレードパスの詳細は、Red Hat Quay Operator のアップグレードを 参照してください。

-

新しい Red Hat Quay レジストリーがインストールされると、クラスター上で必要なアップグレードが自動的に完了します。その後、新しい Red Hat Quay Pod は、最新の y-stream バージョンで起動します。さらに、新しい

QuayPod がスケジュールされ、起動します。 Red Hat Quay UI に移動して、更新が適切に機能していることを確認します。

OpenShift コンソールで Operators → Installed Operators に移動し、Registry Endpoint リンクをクリックします。

重要Red Hat Quay UI が利用可能になるまで、次の手順を実行しないでください。システム A で UI が利用可能になるまで、システム B およびシステム C で Red Hat Quay レジストリーをアップグレードしないでください。

システム A で更新が適切に機能していることを確認し、システム B とシステム C で Red Hat Quay のアップグレードを開始します。Operator のアップグレードにより、Red Hat Quay インストールがアップグレードされ、Pod が再起動されます。

注記データベーススキーマが新しい y-stream インストールに適したものであるため、システム B とシステム C の新しい Pod がすぐに起動します。

更新後、コンポーネントの

overridesを削除して、この手順のステップ 1 で行った変更を元に戻します。以下に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- アップグレード手順の前に、

horizontalpodautoscalerリソースがTrueに設定されていた場合、またはリソース不足の際に Red Hat Quay をスケーリングする場合は、これをTrueに設定します。

6.3.1. OpenShift Container Platform デプロイメント上の Red Hat Quay から geo レプリケートされたサイトを削除する

以下の手順を使用すると、Red Hat Quay 管理者は geo レプリケートされたセットアップ内のサイトを削除できます。

前提条件

- OpenShift Container Platform にログインしている。

-

少なくとも 2 つのサイト (例:

usstorageとeustorage) を使用して Red Hat Quay Geo レプリケーションを設定している。 - 各サイトに、独自の組織、リポジトリー、およびイメージタグがある。

手順

次のコマンドを実行して、定義されたすべてのサイト間で Blob を同期します。

python -m util.backfillreplication

$ python -m util.backfillreplicationCopy to Clipboard Copied! Toggle word wrap Toggle overflow 警告Red Hat Quay

config.yamlファイルからストレージエンジンを削除する前に、定義されているすべてのサイト間ですべての Blob が同期されていることを確認する 必要があります。このコマンドを実行すると、レプリケーションワーカーによって取得されるレプリケーションジョブが作成されます。レプリケートする必要がある Blob がある場合、スクリプトはレプリケートされる Blob の UUID を返します。このコマンドを複数回実行したときに、スクリプトから返された出力が空であっても、レプリケーションプロセスが完了したことを意味するわけではありません。それはレプリケーションのためにキューに入れる Blob が残っていないことを意味します。レプリケーションにかかる割り当て時間は検出された Blob の数によって異なるため、次のステップに進む前に適切に評価してください。

または、Microsoft Azure などのサードパーティーのクラウドツールを使用して、同期ステータスを確認することもできます。

このステップは次に進む前に完了する必要があります。

-

サイト

usstorageの Red Hat Quayconfig.yamlファイルで、eustorageサイトのDISTRIBUTED_STORAGE_CONFIGエントリーを削除します。 次のコマンドを入力して、

Quayアプリケーション Pod を識別します。oc get pod -n <quay_namespace>

$ oc get pod -n <quay_namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

quay390usstorage-quay-app-5779ddc886-2drh2 quay390eustorage-quay-app-66969cd859-n2ssm

quay390usstorage-quay-app-5779ddc886-2drh2 quay390eustorage-quay-app-66969cd859-n2ssmCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを入力して、

usstoragePod でインタラクティブシェルセッションを開きます。oc rsh quay390usstorage-quay-app-5779ddc886-2drh2

$ oc rsh quay390usstorage-quay-app-5779ddc886-2drh2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、

eustorageサイトを完全に削除します。重要次の操作は元に戻すことができません。注意して使用してください。

python -m util.removelocation eustorage

sh-4.4$ python -m util.removelocation eustorageCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第7章 Red Hat Quay Operator によって管理される Red Hat Quay のバックアップおよび復元

OpenShift Container Platform で Red Hat Quay Operator によって管理される場合、このセクション内のコンテンツを使用して Red Hat Quay をバックアップおよび復元します。

7.1. オプション: Red Hat Quay on OpenShift Container Platform の読み取り専用モードを有効にする

Red Hat Quay on OpenShift Container Platform デプロイメントで読み取り専用モードを有効にすると、レジストリーの操作を管理できるようになります。管理者は、読み取り専用モードを有効にしてレジストリーへの書き込みアクセスを制限できます。これは、データの整合性の確保、メンテナンス期間中のリスクの軽減、レジストリーデータへの意図しない変更に対する保護に役立ちます。また、Red Hat Quay レジストリーがオンライン状態を維持し、ユーザーにイメージを提供できるようにするのにも役立ちます。

バックアップおよび復元を行う場合、Red Hat Quay on OpenShift Container Platform デプロイメントをスケールダウンする必要があります。その結果、バックアップ期間中にサービスを利用できなくなります。場合によっては、そのような状況は許容できません。読み取り専用モードを有効にすると、Red Hat Quay on OpenShift Container Platform デプロイメントのバックアップおよび復元手順を実行している間も、サービスの可用性が確保されます。

場合によっては、サービスキーの挿入やその他の手動での設定変更が必要になるため、Red Hat Quay の読み取り専用オプションは使用できないことがあります。読み取り専用モードの代わりに、Red Hat Quay 管理者には DISABLE_PUSHES 機能の有効化を検討することを推奨します。このフィールドを True に設定すると、ユーザーは CLI を使用するときにイメージまたはイメージタグをレジストリーにプッシュできなくなります。DISABLE_PUSHES を有効にすることは、データベースが read-only として設定されないため、read-only モードとは異なります。

このフィールドは、Red Hat Quay 管理者がレジストリーのクォータを計算し、計算が完了するまでイメージのプッシュを無効にしたい場合など、一部の状況で役立つ場合があります。この方法を使用すると、管理者はレジストリー全体を read-only モードにしてデータベースに影響を与えることを回避できるため、ほとんどの操作を引き続き実行できます。

この設定フィールドを有効にする方法の詳細は、その他の設定フィールド を参照してください。

前提条件

Red Hat Enterprise Linux (RHEL) 7.x を使用している場合:

- Red Hat Software Collections List (RHSCL) を有効にした。

- Python 3.6 をインストールした。

-

virtualenvパッケージをダウンロードした。 -

gitCLI をインストールした。

Red Hat Enterprise Linux (RHEL) 8 を使用している場合:

- マシンに Python 3 をインストールした。

-

python3-virtualenvパッケージをダウンロードした。 -

gitCLI をインストールした。

-

https://github.com/quay/quay.gitリポジトリーのクローンを作成した。 -

ocCLI がインストールされている。 -

cluster-admin権限でクラスターにアクセスできる。

7.1.1. Red Hat Quay on OpenShift Container Platform のサービスキーを作成する

Red Hat Quay はサービスキーを使用してさまざまなコンポーネントと通信します。サービスキーは、イメージのスキャン、ログイン、ストレージアクセスなどの要求など、完了した要求に署名するために使用されます。

手順

次のコマンドを入力して、Red Hat Quay Pod のリストを取得します。

oc get pods -n <namespace>

$ oc get pods -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、

Quayコンテナーへのリモートシェルセッションを開きます。oc rsh example-registry-quay-app-76c8f55467-52wjz

$ oc rsh example-registry-quay-app-76c8f55467-52wjzCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、必要なサービスキーを作成します。

python3 tools/generatekeypair.py quay-readonly

sh-4.4$ python3 tools/generatekeypair.py quay-readonlyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Writing public key to quay-readonly.jwk Writing key ID to quay-readonly.kid Writing private key to quay-readonly.pem

Writing public key to quay-readonly.jwk Writing key ID to quay-readonly.kid Writing private key to quay-readonly.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.1.2. PostgreSQL データベースへのキーの追加

PostgreSQL データベースにサービスキーを追加するには、次の手順に従います。

前提条件

- サービスキーを作成した。

手順

次のコマンドを入力して、Red Hat Quay データベース環境に入ります。

oc rsh example-registry-quay-database-76c8f55467-52wjz psql -U <database_username> -d <database_name>

$ oc rsh example-registry-quay-database-76c8f55467-52wjz psql -U <database_username> -d <database_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、

servicekeyapprovalの承認タイプと関連する注記を表示します。quay=# select * from servicekeyapproval;

quay=# select * from servicekeyapproval;Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のクエリーを入力して、Red Hat Quay データベースにサービスキーを追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

INSERT 0 1

INSERT 0 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のクエリーを使用してキー承認を追加します。

quay=# INSERT INTO servicekeyapproval ('approval_type', 'approved_date', 'notes') VALUES ("ServiceKeyApprovalType.SUPERUSER", "CURRENT_DATE", {include_notes_here_on_why_this_is_being_added});quay=# INSERT INTO servicekeyapproval ('approval_type', 'approved_date', 'notes') VALUES ("ServiceKeyApprovalType.SUPERUSER", "CURRENT_DATE", {include_notes_here_on_why_this_is_being_added});Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

INSERT 0 1

INSERT 0 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 作成されたサービスキー行の

approval_idフィールドを、作成されたサービスキー承認のidフィールドに設定します。必要な ID を取得するには、次のSELECTステートメントを使用できます。UPDATE servicekey SET approval_id = (SELECT id FROM servicekeyapproval WHERE approval_type = 'ServiceKeyApprovalType.SUPERUSER') WHERE name = 'quay-readonly';

UPDATE servicekey SET approval_id = (SELECT id FROM servicekeyapproval WHERE approval_type = 'ServiceKeyApprovalType.SUPERUSER') WHERE name = 'quay-readonly';Copy to Clipboard Copied! Toggle word wrap Toggle overflow UPDATE 1

UPDATE 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.1.3. Red Hat Quay on OpenShift Container Platform を読み取り専用モードに設定する

サービスキーを作成し、PostgreSQL データベースに追加したら、OpenShift Container Platform デプロイメントで Quay コンテナーを再起動する必要があります。

OpenShift Container Platform に Red Hat Quay を読み取り専用モードでデプロイするには、OpenShift Container Platform クラスター内に保存されているシークレットを変更する必要があります。シークレットを変更する前に、シークレットのバックアップを作成することを強く推奨します。

前提条件

- サービスキーを作成し、PostgreSQL データベースに追加した。

手順

次のコマンドを入力して、Red Hat Quay on OpenShift Container Platform デプロイメントのシークレット名を読み取ります。

oc get deployment -o yaml <quay_main_app_deployment_name>

$ oc get deployment -o yaml <quay_main_app_deployment_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow base64コマンドを使用して、quay-readonly.kidファイルとquay-readonly.pemファイルをエンコードします。base64 -w0 quay-readonly.kid

$ base64 -w0 quay-readonly.kidCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

ZjUyNDFm...

ZjUyNDFm...Copy to Clipboard Copied! Toggle word wrap Toggle overflow base64 -w0 quay-readonly.pem

$ base64 -w0 quay-readonly.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

LS0tLS1CRUdJTiBSU0E...

LS0tLS1CRUdJTiBSU0E...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、現在の設定バンドルとシークレットを取得します。

oc get secret quay-config-secret-name -o json | jq '.data."config.yaml"' | cut -d '"' -f2 | base64 -d -w0 > config.yaml

$ oc get secret quay-config-secret-name -o json | jq '.data."config.yaml"' | cut -d '"' -f2 | base64 -d -w0 > config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow config.yamlファイルを編集し、次の情報を追加します。# ... REGISTRY_STATE: readonly INSTANCE_SERVICE_KEY_KID_LOCATION: 'conf/stack/quay-readonly.kid' INSTANCE_SERVICE_KEY_LOCATION: 'conf/stack/quay-readonly.pem' # ...

# ... REGISTRY_STATE: readonly INSTANCE_SERVICE_KEY_KID_LOCATION: 'conf/stack/quay-readonly.kid' INSTANCE_SERVICE_KEY_LOCATION: 'conf/stack/quay-readonly.pem' # ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行してファイルを保存し、

base64でエンコードします。base64 -w0 quay-config.yaml

$ base64 -w0 quay-config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Quay Operator Pod を

0にスケールダウンします。これにより、シークレットの編集後に Operator がシークレットを調整することがなくなります。oc scale --replicas=0 deployment quay-operator -n openshift-operators

$ oc scale --replicas=0 deployment quay-operator -n openshift-operatorsCopy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットを編集し、新しい内容を追加します。

oc edit secret quay-config-secret-name -n quay-namespace

$ oc edit secret quay-config-secret-name -n quay-namespaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Quay on OpenShift Container Platform デプロイメントを読み取り専用モードで実行すると、レジストリーの操作を安全に管理しながら、バックアップや復元などのアクションを実行できます。

7.1.3.1. Red Hat Quay on OpenShift Container Platform を読み取り専用デプロイメントからスケールアップする

Red Hat Quay on OpenShift Container Platform を読み取り専用モードにしておく必要がなくなったら、デプロイメントをスケールアップし、追加した内容をシークレットから削除できます。

手順

config.yamlファイルを編集し、次の情報を削除します。# ... REGISTRY_STATE: readonly INSTANCE_SERVICE_KEY_KID_LOCATION: 'conf/stack/quay-readonly.kid' INSTANCE_SERVICE_KEY_LOCATION: 'conf/stack/quay-readonly.pem' # ...

# ... REGISTRY_STATE: readonly INSTANCE_SERVICE_KEY_KID_LOCATION: 'conf/stack/quay-readonly.kid' INSTANCE_SERVICE_KEY_LOCATION: 'conf/stack/quay-readonly.pem' # ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、Red Hat Quay Operator をスケールアップします。

oc scale --replicas=1 deployment quay-operator -n openshift-operators

oc scale --replicas=1 deployment quay-operator -n openshift-operatorsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2. Red Hat Quay のバックアップ

PostgreSQL イメージで提供されるツールまたは独自のバックアップインフラストラクチャーのいずれかを使用して、データベースのバックアップを定期的に実行する必要があります。Red Hat Quay Operator は、PostgreSQL データベースがバックアップされていることを確認しません。

この手順では、Red Hat Quay PostgreSQL データベースのバックアップを説明します。Clair PostgreSQL データベースのバックアップは説明しません。厳密に言えば、Clair PostgreSQL データベースは再作成できるため、バックアップする必要はありません。ゼロから再作成する場合は、Red Hat Quay デプロイメント内のすべてのイメージがスキャンされた後、情報が再入力されるまで待つことになります。このダウンタイム中は、セキュリティーレポートを利用できません。

Clair PostgreSQL データベースのバックアップを検討している場合は、データベースのサイズが Red Hat Quay 内に保存されているイメージの数に依存することを考慮する必要があります。データベースが非常に大きくなる可能性があるためです。

この手順では、Operator を使用して Red Hat Quay on OpenShift Container Platform のバックアップを作成する方法を説明します。

前提条件

-

Red Hat Quay Operator を使用して、OpenShift Container Platform 上に Red Hat Quay を正常にデプロイしている。ステータス条件

AvailableがTrueに設定されています。 -

コンポーネント

quay、postgres、およびobjectstorageがmanaged: trueに設定されている。 -

コンポーネント

clairがmanaged: trueに設定されている場合、コンポーネントclairpostgresもmanaged: trueに設定されている (Red Hat Quay v3.7 以降)。

デプロイメントに部分的に管理されていないデータベースまたはストレージコンポーネントが含まれ、PostgreSQL または S3 互換オブジェクトストレージの外部サービスを使用している場合、Red Hat Quay デプロイメントを実行するには、サービスプロバイダーまたはベンダーのドキュメントを参照してデータのバックアップを作成してください。このガイドで説明されているツールは、外部 PostgreSQL データベースまたはオブジェクトストレージのバックアップの開始点として参照できます。

7.2.1. Red Hat Quay 設定のバックアップ

Red Hat Quay の設定をバックアップするには、次の手順を実行します。

手順

QuayRegistryカスタムリソースをエクスポートしてバックアップするには、次のコマンドを入力します。oc get quayregistry <quay_registry_name> -n <quay_namespace> -o yaml > quay-registry.yaml

$ oc get quayregistry <quay_registry_name> -n <quay_namespace> -o yaml > quay-registry.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 作成される

quayregistry.yamlを編集し、ステータスセクションおよび以下のメタデータフィールドを削除します。metadata.creationTimestamp metadata.finalizers metadata.generation metadata.resourceVersion metadata.uid

metadata.creationTimestamp metadata.finalizers metadata.generation metadata.resourceVersion metadata.uidCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、マネージドキーのシークレットをバックアップします。

注記Red Hat Quay 3.7.0 より前のバージョンを実行している場合は、この手順を省略できます。一部のシークレットは Red Hat Quay の初回デプロイ時に自動的に生成されます。これらは

QuayRegistryリソースの namespace で、<quay_registry_name>-quay-registry-managed-secret-keysというシークレットに保存されます。oc get secret -n <quay_namespace> <quay_registry_name>-quay-registry-managed-secret-keys -o yaml > managed_secret_keys.yaml

$ oc get secret -n <quay_namespace> <quay_registry_name>-quay-registry-managed-secret-keys -o yaml > managed_secret_keys.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 作成された

managed_secret_keys.yamlファイルを編集し、エントリーmetadata.ownerReferencesを削除します。managed_secret_keys.yamlファイルは、以下のようになります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow dataプロパティーの情報はすべて同じままにする必要があります。次のコマンドを入力して、現在の

Quay設定ファイルをリダイレクトします。oc get secret -n <quay-namespace> $(oc get quayregistry <quay_registry_name> -n <quay_namespace> -o jsonpath='{.spec.configBundleSecret}') -o yaml > config-bundle.yaml$ oc get secret -n <quay-namespace> $(oc get quayregistry <quay_registry_name> -n <quay_namespace> -o jsonpath='{.spec.configBundleSecret}') -o yaml > config-bundle.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow QuayPod 内にマウントされた/conf/stack/config.yamlファイルをバックアップします。oc exec -it quay_pod_name -- cat /conf/stack/config.yaml > quay_config.yaml

$ oc exec -it quay_pod_name -- cat /conf/stack/config.yaml > quay_config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Quayデータベース名を取得します。oc -n <quay_namespace> rsh $(oc get pod -l app=quay -o NAME -n <quay_namespace> |head -n 1) cat /conf/stack/config.yaml|awk -F"/" '/^DB_URI/ {print $4}'$ oc -n <quay_namespace> rsh $(oc get pod -l app=quay -o NAME -n <quay_namespace> |head -n 1) cat /conf/stack/config.yaml|awk -F"/" '/^DB_URI/ {print $4}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

quayregistry-quay-database

quayregistry-quay-databaseCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.2. Red Hat Quay デプロイメントのスケールダウン

Red Hat Quay デプロイメントをスケールダウンするには、次の手順を実行します。

この手順は、Red Hat Quay デプロイメントの状態の整合性のあるバックアップを作成するために必要になります。PostgreSQL データベースや S3 互換オブジェクトストレージが外部サービスによって提供されるセットアップ (Red Hat Quay Operator で管理されない) を含め、この手順を省略しないでください。

手順

Red Hat Quay デプロイメントのバージョンに応じて、次のいずれかのオプションを使用してデプロイメントをスケールダウンします。

Operator バージョン 3.7 以降: Red Hat Quay の自動スケーリングを無効にし、Red Hat Quay、ミラーワーカー、および Clair (管理される場合) のレプリカ数をオーバーライドすることで Red Hat Quay デプロイメントを縮小します。

QuayRegistryリソースは、以下のようになります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow Operator バージョン 3.6 以前: まず Red Hat Quay レジストリーをスケールダウンしてからマネージドの Red Hat Quay リソースをスケールダウンして、Red Hat Quay デプロイメントをスケールダウンします。

oc scale --replicas=0 deployment $(oc get deployment -n <quay-operator-namespace>|awk '/^quay-operator/ {print $1}') -n <quay-operator-namespace>$ oc scale --replicas=0 deployment $(oc get deployment -n <quay-operator-namespace>|awk '/^quay-operator/ {print $1}') -n <quay-operator-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc scale --replicas=0 deployment $(oc get deployment -n <quay-namespace>|awk '/quay-app/ {print $1}') -n <quay-namespace>$ oc scale --replicas=0 deployment $(oc get deployment -n <quay-namespace>|awk '/quay-app/ {print $1}') -n <quay-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc scale --replicas=0 deployment $(oc get deployment -n <quay-namespace>|awk '/quay-mirror/ {print $1}') -n <quay-namespace>$ oc scale --replicas=0 deployment $(oc get deployment -n <quay-namespace>|awk '/quay-mirror/ {print $1}') -n <quay-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc scale --replicas=0 deployment $(oc get deployment -n <quay-namespace>|awk '/clair-app/ {print $1}') -n <quay-namespace>$ oc scale --replicas=0 deployment $(oc get deployment -n <quay-namespace>|awk '/clair-app/ {print $1}') -n <quay-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

registry-quay-app、registry-quay-mirror、およびregistry-clair-appPod (どのコンポーネントを Red Hat Quay Operator がマネージするように設定したかにより異なります) が非表示になるまで待機します。以下のコマンドを実行してステータスを確認できます。oc get pods -n <quay_namespace>

$ oc get pods -n <quay_namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例:

oc get pod

$ oc get podCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

quay-operator.v3.7.1-6f9d859bd-p5ftc 1/1 Running 0 12m quayregistry-clair-postgres-7487f5bd86-xnxpr 1/1 Running 1 (12m ago) 12m quayregistry-quay-app-upgrade-xq2v6 0/1 Completed 0 12m quayregistry-quay-database-859d5445ff-cqthr 1/1 Running 0 12m quayregistry-quay-redis-84f888776f-hhgms 1/1 Running 0 12m

quay-operator.v3.7.1-6f9d859bd-p5ftc 1/1 Running 0 12m quayregistry-clair-postgres-7487f5bd86-xnxpr 1/1 Running 1 (12m ago) 12m quayregistry-quay-app-upgrade-xq2v6 0/1 Completed 0 12m quayregistry-quay-database-859d5445ff-cqthr 1/1 Running 0 12m quayregistry-quay-redis-84f888776f-hhgms 1/1 Running 0 12mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.3. Red Hat Quay マネージドデータベースのバックアップ

Red Hat Quay マネージドデータベースをバックアップするには、次の手順を実行します。

Red Hat Quay デプロイメントが外部のアンマネージド PostgreSQL データベースで設定されている場合は、これらのデータベースの一貫したバックアップを作成する方法についてベンダーのドキュメントを参照してください。

手順

Quay PostgreSQL Pod 名を特定します。

oc get pod -l quay-component=postgres -n <quay_namespace> -o jsonpath='{.items[0].metadata.name}'$ oc get pod -l quay-component=postgres -n <quay_namespace> -o jsonpath='{.items[0].metadata.name}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例:

quayregistry-quay-database-59f54bb7-58xs7

quayregistry-quay-database-59f54bb7-58xs7Copy to Clipboard Copied! Toggle word wrap Toggle overflow バックアップデータベースをダウンロードします。

oc -n <quay_namespace> exec quayregistry-quay-database-59f54bb7-58xs7 -- /usr/bin/pg_dump -C quayregistry-quay-database > backup.sql

$ oc -n <quay_namespace> exec quayregistry-quay-database-59f54bb7-58xs7 -- /usr/bin/pg_dump -C quayregistry-quay-database > backup.sqlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.3.1. Red Hat Quay マネージドオブジェクトストレージのバックアップ

Red Hat Quay マネージドオブジェクトストレージをバックアップするには、次の手順を実行します。このセクションの手順は、以下の設定に適用されます。

- スタンドアロンのマルチクラウドオブジェクトゲートウェイ設定

- OpenShift Data Foundation ストレージでは、Red Hat Quay Operator が ObjectStorageBucketClaim API 経由で S3 オブジェクトストレージバケットをプロビジョニングしている必要があります。

Red Hat Quay デプロイメントが外部 (マネージド外) オブジェクトストレージで設定されている場合は、Quay のストレージバケットのコンテンツのコピーを作成する方法についてベンダーのドキュメントを参照してください。

手順

次のコマンドを入力し、

AWS_ACCESS_KEY_IDをデコードしてエクスポートします。export AWS_ACCESS_KEY_ID=$(oc get secret -l app=noobaa -n <quay-namespace> -o jsonpath='{.items[0].data.AWS_ACCESS_KEY_ID}' |base64 -d)$ export AWS_ACCESS_KEY_ID=$(oc get secret -l app=noobaa -n <quay-namespace> -o jsonpath='{.items[0].data.AWS_ACCESS_KEY_ID}' |base64 -d)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力し、

AWS_SECRET_ACCESS_KEY_IDをデコードしてエクスポートします。export AWS_SECRET_ACCESS_KEY=$(oc get secret -l app=noobaa -n <quay-namespace> -o jsonpath='{.items[0].data.AWS_SECRET_ACCESS_KEY}' |base64 -d)$ export AWS_SECRET_ACCESS_KEY=$(oc get secret -l app=noobaa -n <quay-namespace> -o jsonpath='{.items[0].data.AWS_SECRET_ACCESS_KEY}' |base64 -d)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 新しいディレクトリーを作成します。

mkdir blobs

$ mkdir blobsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

次のコマンドを入力して、すべての Blob をディレクトリーにコピーします。

aws s3 sync --no-verify-ssl --endpoint https://$(oc get route s3 -n openshift-storage -o jsonpath='{.spec.host}') s3://$(oc get cm -l app=noobaa -n <quay-namespace> -o jsonpath='{.items[0].data.BUCKET_NAME}') ./blobs$ aws s3 sync --no-verify-ssl --endpoint https://$(oc get route s3 -n openshift-storage -o jsonpath='{.spec.host}') s3://$(oc get cm -l app=noobaa -n <quay-namespace> -o jsonpath='{.items[0].data.BUCKET_NAME}') ./blobsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.4. Red Hat Quay デプロイメントのバックアップのスケーリング

Red Hat Quay デプロイメントのバージョンに応じて、次のいずれかのオプションを使用してデプロイメントをスケールアップします。

Operator バージョン 3.7 以降: 自動スケーリングを再度有効にし、必要な場合は Quay、ミラーワーカー、および Clair のレプリカオーバーライドを適宜削除して、Red Hat Quay デプロイメントをスケールアップします。

QuayRegistryリソースは、以下のようになります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow Operator バージョン 3.6 以前の場合: Red Hat Quay レジストリーをスケールアップして、Red Hat Quay デプロイメントをスケールアップします。

oc scale --replicas=1 deployment $(oc get deployment -n <quay_operator_namespace> | awk '/^quay-operator/ {print $1}') -n <quay_operator_namespace>$ oc scale --replicas=1 deployment $(oc get deployment -n <quay_operator_namespace> | awk '/^quay-operator/ {print $1}') -n <quay_operator_namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

次のコマンドを入力して、Red Hat Quay デプロイメントのステータスを確認します。

oc wait quayregistry registry --for=condition=Available=true -n <quay_namespace>

$ oc wait quayregistry registry --for=condition=Available=true -n <quay_namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3. Red Hat Quay の復元

Red Hat Quay オペレーターがデータベースを管理している場合は、次の手順を使用して Red Hat Quay を復元します。これは、Red Hat Quay レジストリーをバックアップした後に実行する必要があります。詳細は、Red Hat Quay のバックアップ を参照してください。

前提条件

- Red Hat Quay が、Red Hat Quay Operator を使用して OpenShift Container Platform にデプロイされている。

- Red Hat Quay Operator によって管理される Red Hat Quay 設定のバックアップが、Red Hat Quay のバックアップ セクションの手順に従って作成されている。

- Red Hat Quay データベースがバックアップされている。

- Red Hat Quay で使用されるオブジェクトストレージバケットがバックアップされている。

-

コンポーネント

quay、postgres、およびobjectstorageがmanaged: trueに設定されている。 -

コンポーネント

clairがmanaged: trueに設定されている場合、コンポーネントclairpostgresもmanaged: trueに設定されている (Red Hat Quay v3.7 以降)。 - OpenShift Container Platform クラスターのターゲット namespace で、Red Hat Quay Operator に管理される Red Hat Quay デプロイメントを実行していない。

デプロイメントに部分的に管理されていないデータベースまたはストレージコンポーネントが含まれ、PostgreSQL または S3 互換オブジェクトストレージの外部サービスを使用している場合、Red Hat Quay デプロイメントを実行するには、サービスプロバイダーまたはベンダーのドキュメントを参照して、Red Hat Quay を復元する前にバックアップからデータを復元してください。

7.3.1. バックアップからの Red Hat Quay およびその設定の復元

Red Hat Quay とその設定ファイルをバックアップから復元するには、次の手順を実行します。

これらの手順では、Red Hat Quay のバックアップ ガイドのプロセスに従い、同じ名前のバックアップファイルを作成していることを前提としています。

手順

次のコマンドを入力して、バックアップされた Red Hat Quay 設定を復元します。

oc create -f ./config-bundle.yaml

$ oc create -f ./config-bundle.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要エラー

Error from server (AlreadyExists): error when creating "./config-bundle.yaml": secrets "config-bundle-secret" already existsが発生した場合は、$ oc delete Secret config-bundle-secret -n <quay-namespace>を使用して既存リソースを削除し、$ oc create -f ./config-bundle.yamlで再作成する必要があります。次のコマンドを入力して、生成されたキーをバックアップから復元します。

oc create -f ./managed-secret-keys.yaml

$ oc create -f ./managed-secret-keys.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow QuayRegistryカスタムリソースを復元します。oc create -f ./quay-registry.yaml

$ oc create -f ./quay-registry.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Quay デプロイメントのステータスを確認し、これが利用可能になるまで待機します。

oc wait quayregistry registry --for=condition=Available=true -n <quay-namespace>

$ oc wait quayregistry registry --for=condition=Available=true -n <quay-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3.2. Red Hat Quay デプロイメントのスケールダウン

Red Hat Quay デプロイメントをスケールダウンするには、次の手順を実行します。

手順

Red Hat Quay デプロイメントのバージョンに応じて、次のいずれかのオプションを使用してデプロイメントをスケールダウンします。

Operator バージョン 3.7 以降: Red Hat Quay の自動スケーリングを無効にし、Red Hat Quay、ミラーワーカー、および Clair (マネージドの場合) のレプリカ数をオーバーライドすることで Quay デプロイメントを縮小します。

QuayRegistryリソースは、以下のようになります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow Operator バージョン 3.6 以前: まず Red Hat Quay レジストリーをスケールダウンしてからマネージドの Red Hat Quay リソースをスケールダウンして、Red Hat Quay デプロイメントをスケールダウンします。

oc scale --replicas=0 deployment $(oc get deployment -n <quay-operator-namespace>|awk '/^quay-operator/ {print $1}') -n <quay-operator-namespace>$ oc scale --replicas=0 deployment $(oc get deployment -n <quay-operator-namespace>|awk '/^quay-operator/ {print $1}') -n <quay-operator-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc scale --replicas=0 deployment $(oc get deployment -n <quay-namespace>|awk '/quay-app/ {print $1}') -n <quay-namespace>$ oc scale --replicas=0 deployment $(oc get deployment -n <quay-namespace>|awk '/quay-app/ {print $1}') -n <quay-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc scale --replicas=0 deployment $(oc get deployment -n <quay-namespace>|awk '/quay-mirror/ {print $1}') -n <quay-namespace>$ oc scale --replicas=0 deployment $(oc get deployment -n <quay-namespace>|awk '/quay-mirror/ {print $1}') -n <quay-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc scale --replicas=0 deployment $(oc get deployment -n <quay-namespace>|awk '/clair-app/ {print $1}') -n <quay-namespace>$ oc scale --replicas=0 deployment $(oc get deployment -n <quay-namespace>|awk '/clair-app/ {print $1}') -n <quay-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

registry-quay-app、registry-quay-mirror、およびregistry-clair-appPod (どのコンポーネントを Red Hat Quay Operator がマネージするように設定したかにより異なります) が非表示になるまで待機します。以下のコマンドを実行してステータスを確認できます。oc get pods -n <quay-namespace>

$ oc get pods -n <quay-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例:

registry-quay-config-editor-77847fc4f5-nsbbv 1/1 Running 0 9m1s registry-quay-database-66969cd859-n2ssm 1/1 Running 0 6d1h registry-quay-redis-7cc5f6c977-956g8 1/1 Running 0 5d21h

registry-quay-config-editor-77847fc4f5-nsbbv 1/1 Running 0 9m1s registry-quay-database-66969cd859-n2ssm 1/1 Running 0 6d1h registry-quay-redis-7cc5f6c977-956g8 1/1 Running 0 5d21hCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3.3. Red Hat Quay データベースの復元

Red Hat Quay データベースを復元するには、次の手順を実行します。

手順

次のコマンドを入力して、

Quayデータベース Pod を識別します。oc get pod -l quay-component=postgres -n <quay-namespace> -o jsonpath='{.items[0].metadata.name}'$ oc get pod -l quay-component=postgres -n <quay-namespace> -o jsonpath='{.items[0].metadata.name}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例:

quayregistry-quay-database-59f54bb7-58xs7

quayregistry-quay-database-59f54bb7-58xs7Copy to Clipboard Copied! Toggle word wrap Toggle overflow ローカル環境および Pod にコピーして、バックアップをアップロードします。

oc cp ./backup.sql -n <quay-namespace> registry-quay-database-66969cd859-n2ssm:/tmp/backup.sql

$ oc cp ./backup.sql -n <quay-namespace> registry-quay-database-66969cd859-n2ssm:/tmp/backup.sqlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、データベースへのリモートターミナルを開きます。

oc rsh -n <quay-namespace> registry-quay-database-66969cd859-n2ssm

$ oc rsh -n <quay-namespace> registry-quay-database-66969cd859-n2ssmCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して psql を入力します。

bash-4.4$ psql

bash-4.4$ psqlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行してデータベースをリスト表示できます。

postgres=# \l

postgres=# \lCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

List of databases Name | Owner | Encoding | Collate | Ctype | Access privileges ----------------------------+----------------------------+----------+------------+------------+----------------------- postgres | postgres | UTF8 | en_US.utf8 | en_US.utf8 | quayregistry-quay-database | quayregistry-quay-database | UTF8 | en_US.utf8 | en_US.utf8 |List of databases Name | Owner | Encoding | Collate | Ctype | Access privileges ----------------------------+----------------------------+----------+------------+------------+----------------------- postgres | postgres | UTF8 | en_US.utf8 | en_US.utf8 | quayregistry-quay-database | quayregistry-quay-database | UTF8 | en_US.utf8 | en_US.utf8 |Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力してデータベースを削除します。

postgres=# DROP DATABASE "quayregistry-quay-database";

postgres=# DROP DATABASE "quayregistry-quay-database";Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

DROP DATABASE

DROP DATABASECopy to Clipboard Copied! Toggle word wrap Toggle overflow postgres CLI を終了して bash-4.4 を再入力します。

\q

\qCopy to Clipboard Copied! Toggle word wrap Toggle overflow PostgreSQL データベースをバックアップデータベースにリダイレクトします。

psql < /tmp/backup.sql

sh-4.4$ psql < /tmp/backup.sqlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して bash を終了します。

exit

sh-4.4$ exitCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3.4. Red Hat Quay オブジェクトストレージデータの復元

Red Hat Quay オブジェクトストレージデータを復元するには、次の手順を実行します。

手順

次のコマンドを入力して、

AWS_ACCESS_KEY_IDをエクスポートします。export AWS_ACCESS_KEY_ID=$(oc get secret -l app=noobaa -n <quay-namespace> -o jsonpath='{.items[0].data.AWS_ACCESS_KEY_ID}' |base64 -d)$ export AWS_ACCESS_KEY_ID=$(oc get secret -l app=noobaa -n <quay-namespace> -o jsonpath='{.items[0].data.AWS_ACCESS_KEY_ID}' |base64 -d)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、

AWS_SECRET_ACCESS_KEYをエクスポートします。export AWS_SECRET_ACCESS_KEY=$(oc get secret -l app=noobaa -n <quay-namespace> -o jsonpath='{.items[0].data.AWS_SECRET_ACCESS_KEY}' |base64 -d)$ export AWS_SECRET_ACCESS_KEY=$(oc get secret -l app=noobaa -n <quay-namespace> -o jsonpath='{.items[0].data.AWS_SECRET_ACCESS_KEY}' |base64 -d)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、すべての Blob をバケットにアップロードします。

aws s3 sync --no-verify-ssl --endpoint https://$(oc get route s3 -n openshift-storage -o jsonpath='{.spec.host}') ./blobs s3://$(oc get cm -l app=noobaa -n <quay-namespace> -o jsonpath='{.items[0].data.BUCKET_NAME}')$ aws s3 sync --no-verify-ssl --endpoint https://$(oc get route s3 -n openshift-storage -o jsonpath='{.spec.host}') ./blobs s3://$(oc get cm -l app=noobaa -n <quay-namespace> -o jsonpath='{.items[0].data.BUCKET_NAME}')Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3.5. Red Hat Quay デプロイメントのスケールアップ

Red Hat Quay デプロイメントのバージョンに応じて、次のいずれかのオプションを使用してデプロイメントをスケールアップします。

Operator バージョン 3.7 以降: 自動スケーリングを再度有効にし、必要な場合は Quay、ミラーワーカー、および Clair のレプリカオーバーライドを適宜削除して、Red Hat Quay デプロイメントをスケールアップします。

QuayRegistryリソースは、以下のようになります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow Operator バージョン 3.6 以前の場合: Red Hat Quay レジストリーを再度スケールアップして、Red Hat Quay デプロイメントをスケールアップします。

oc scale --replicas=1 deployment $(oc get deployment -n <quay-operator-namespace> | awk '/^quay-operator/ {print $1}') -n <quay-operator-namespace>$ oc scale --replicas=1 deployment $(oc get deployment -n <quay-operator-namespace> | awk '/^quay-operator/ {print $1}') -n <quay-operator-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Red Hat Quay デプロイメントのステータスを確認します。

oc wait quayregistry registry --for=condition=Available=true -n <quay-namespace>

$ oc wait quayregistry registry --for=condition=Available=true -n <quay-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第8章 ボリュームサイズのオーバーライド

マネージドコンポーネントにプロビジョニングされるストレージリソースの希望のサイズを指定できます。Clair および PostgreSQL データベースのデフォルトサイズは 50Gi です。パフォーマンス上の理由がある場合や、ストレージバックエンドにサイズ変更機能がない場合など、十分な容量を事前に選択できるようになりました。

以下の例では、Clair および Quay PostgreSQL データベースのボリュームサイズは 70Gi に設定されています。

第9章 コンテナーセキュリティー Operator での Pod イメージのスキャン

Container Security Operator (CSO) は、OpenShift Container Platform およびその他の Kubernetes プラットフォームで利用可能な Clair セキュリティースキャナーのアドオンです。CSO を使用すると、ユーザーはアクティブな Pod に関連付けられているコンテナーイメージをスキャンして、既知の脆弱性を見つけることができます。

CSO は、Red Hat Quay と Clair なしでは機能しません。

Container Security Operator (CSO) には、次の機能が含まれています。

- 指定された namespace またはすべての namespace の Pod に関連付けられたコンテナーを監視します。

- コンテナーのソースであるコンテナーレジストリーにクエリーを実行して、脆弱性情報を取得します (イメージのレジストリーが、Clair スキャンを使用する Red Hat Quay レジストリーなどのイメージスキャンをサポートしている場合)。

-

Kubernetes API の

ImageManifestVulnオブジェクトを使用して脆弱性を公開します。

CSO を Kubernetes にインストールする手順を見るには、Container Security OperatorHub.io ページから Install ボタンを選択します。

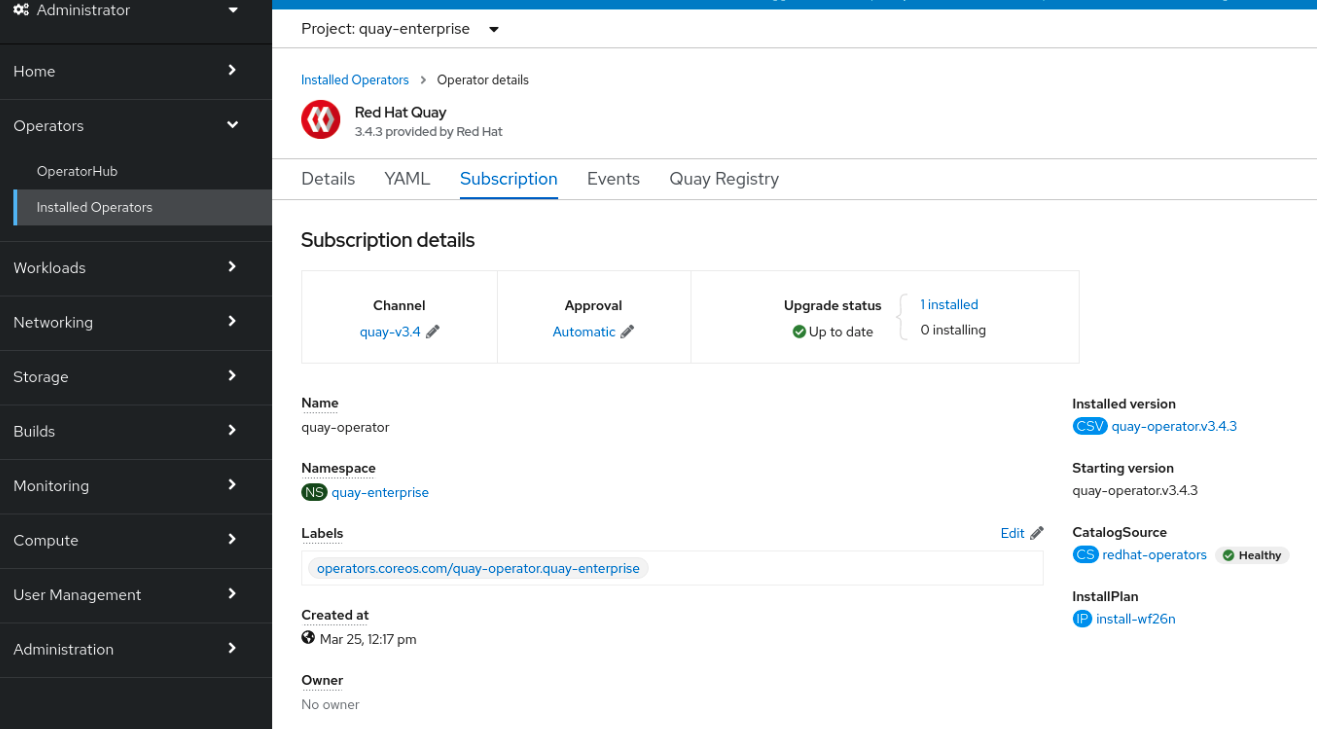

9.1. OpenShift Container Platform での Container Security Operator のダウンロードおよび実行

Container Security Operator (CSO) をダウンロードするには、次の手順を使用します。

次の手順では、CSO を marketplace-operators namespace にインストールします。これにより、OpenShift Container Platform クラスターのすべての namespace で CSO を使用できるようになります。

手順

- OpenShift Container Platform コンソールページで、Operators → OperatorHub を選択し、Container Security Operator を検索します。

- Container Security Operator を選択し、Install を選択して Create Operator Subscription ページに移動します。

- 設定 (デフォルトでは、すべての namespace と自動承認戦略) を確認し、Subscribe を選択します。しばらくすると、Installed Operators 画面に Container Security が表示されます。

オプション: カスタム証明書を CSO に追加できます。以下の例では、現在のディレクトリーに

quay.crtという名前の証明書を作成します。次に、次のコマンドを実行して証明書を CSO に追加します。oc create secret generic container-security-operator-extra-certs --from-file=quay.crt -n openshift-operators

$ oc create secret generic container-security-operator-extra-certs --from-file=quay.crt -n openshift-operatorsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記新しい証明書を有効にするには、Operator Pod を再起動する必要があります。

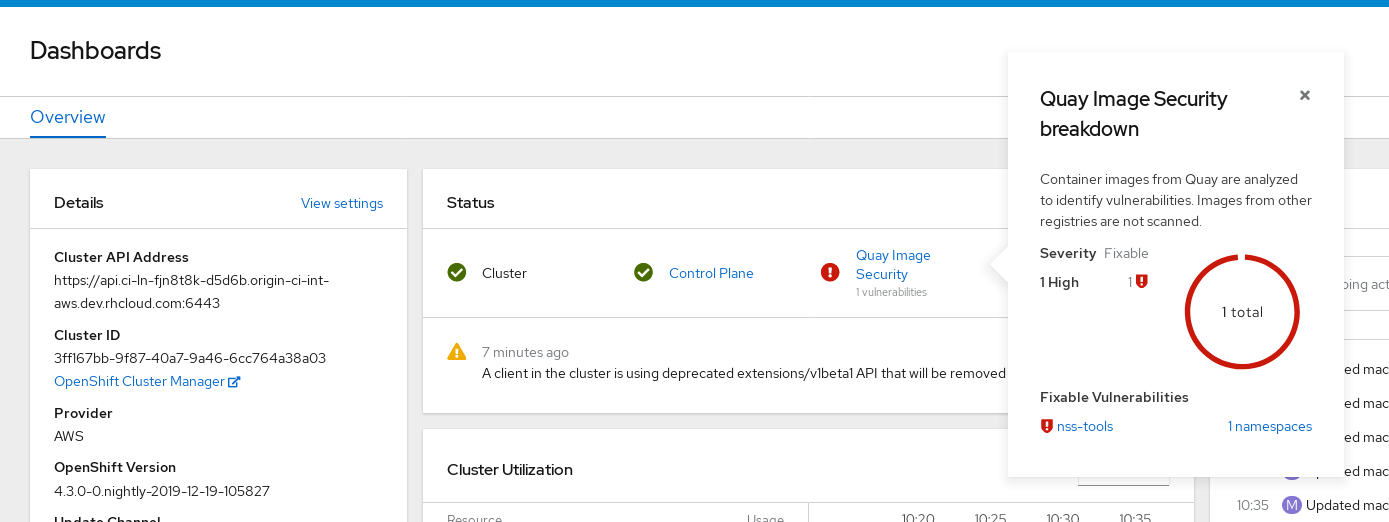

Home → Overview に移動します。ステータスセクションの下に、Image Vulnerabilities へのリンクが表示され、これまでに見つかった脆弱性の数のリストが表示されます。次の図に示すように、リンクを選択するとセキュリティーの内訳が表示されます。

重要

重要Container Security Operator は現在、Red Hat セキュリティーアドバイザリーの壊れたリンクを提供しています。たとえば、リンク

https://access.redhat.com/errata/RHSA-2023:1842%20https://access.redhat.com/security/cve/CVE-2023-23916が提供される場合があります。URL 内の%20はスペース文字を表しますが、現時点では 2 つの URL が 1 つの不完全な URL に結合されます (例:https://access.redhat.com/errata/RHSA-2023:1842とhttps://access.redhat.com/security/cve/CVE-2023-23916。一時的な回避策として、各 URL をブラウザーにコピーして、適切なページに移動できます。これは既知の問題であり、Red Hat Quay の今後のバージョンで修正される予定です。この時点で、検出された脆弱性をフォローするために以下の 2 つのいずれかの操作を実行できます。

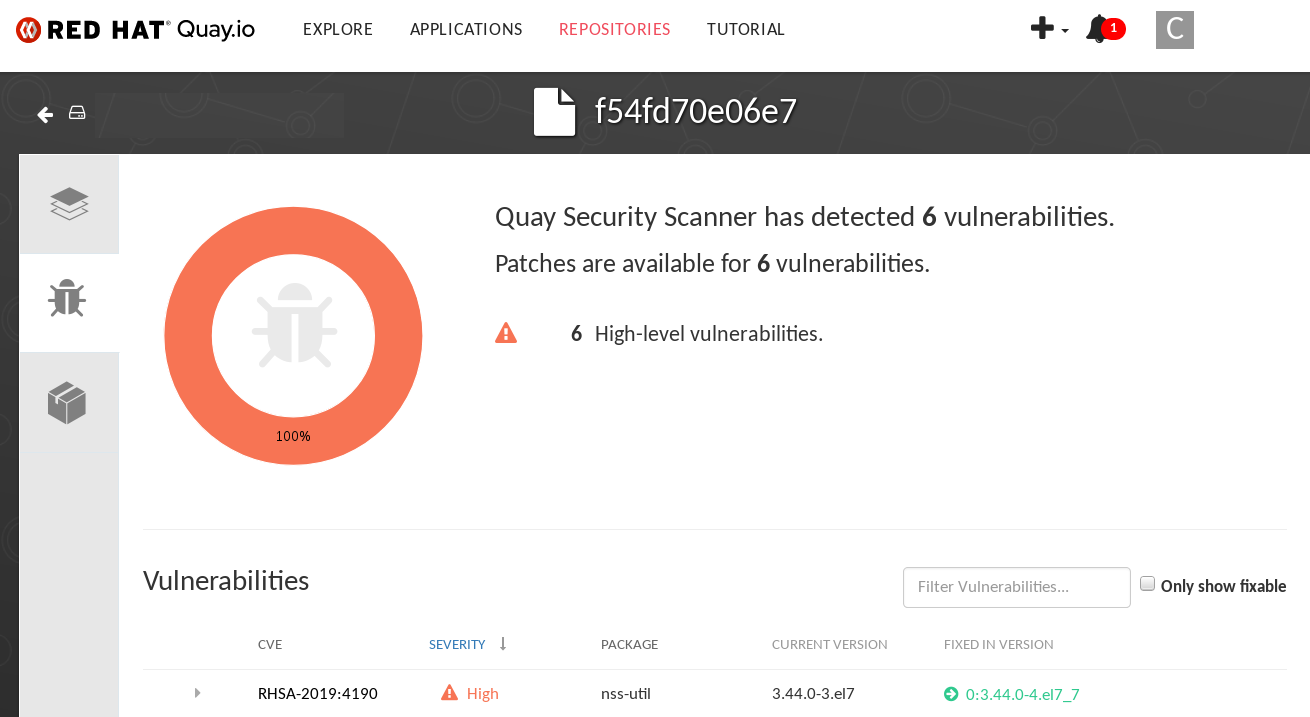

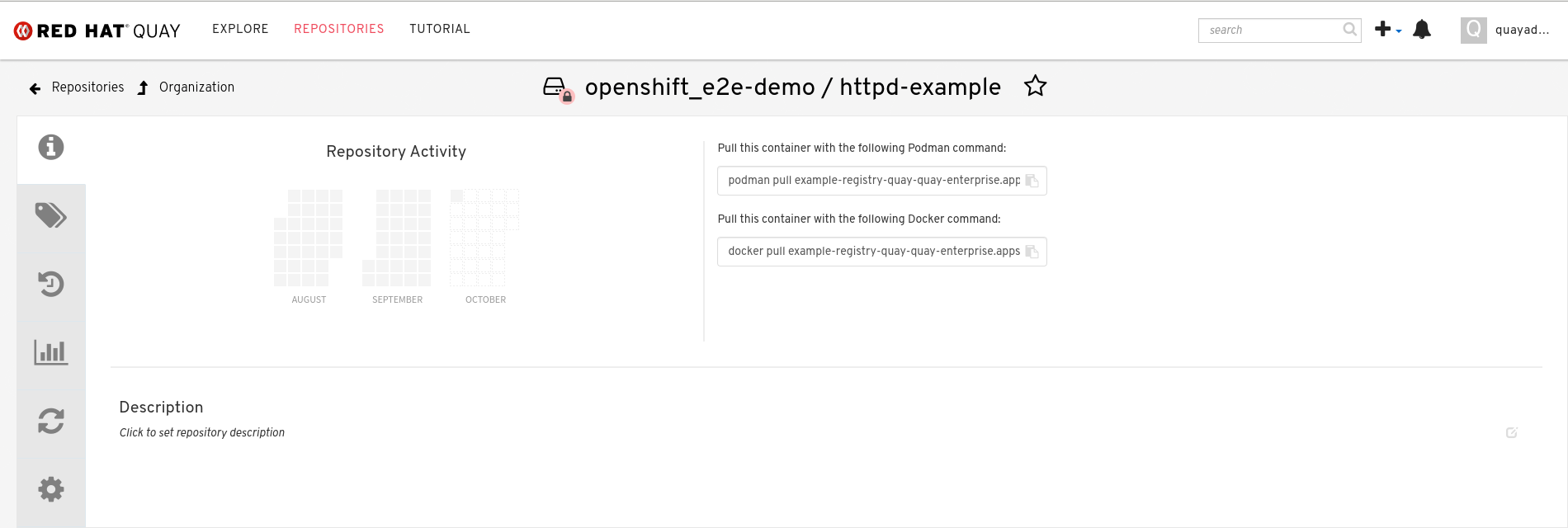

脆弱性へのリンクを選択します。コンテナーのレジストリー、Red Hat Quay、またはコンテナーを取得したその他のレジストリーに移動し、脆弱性に関する情報が表示されます。以下の図は、Quay.io レジストリーから検出された脆弱性の例を示しています。

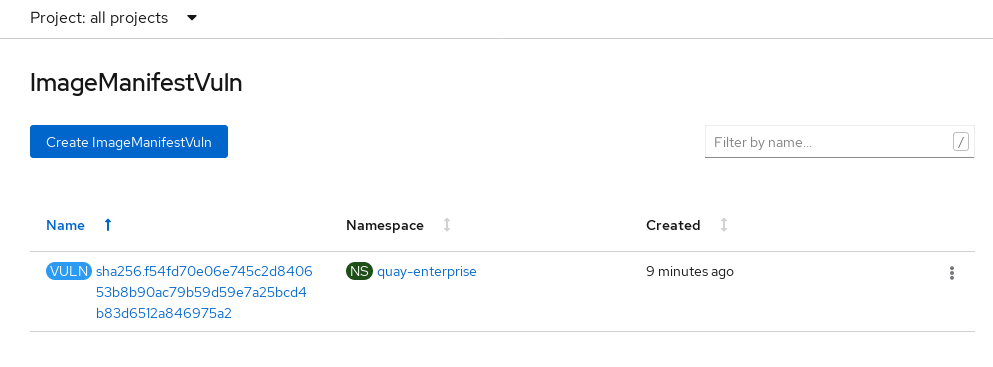

namespace リンクを選択すると、Image Manifest Vulnerabilities ページに移動し、選択したイメージの名前と、そのイメージが実行されているすべての namespace を確認できます。以下の図は、特定の脆弱なイメージが 2 つの namespace で実行されていることを示しています。

この手順を実行すると、どのイメージに脆弱性があるか、それらの脆弱性を修正するために何をしなければならないか、およびイメージが実行されたすべての namespace がわかります。これを知っていると、次のアクションを実行できます。

- イメージを実行しているユーザーに、脆弱性を修正する必要があることを警告します。

デプロイメント、またはイメージが含まれる Pod を開始したオブジェクトを削除して、イメージの実行を停止します。

注記Pod を削除した場合、ダッシュボードで脆弱性がリセットされるまでに数分かかる場合があります。

9.2. CLI でのイメージ脆弱性のクエリー

コマンドラインインターフェイス (CLI) からイメージの脆弱性をクエリーするには、次の手順を使用します。

手順

次のコマンドを入力して、検出された脆弱性をクエリーします。

oc get vuln --all-namespaces

$ oc get vuln --all-namespacesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAMESPACE NAME AGE default sha256.ca90... 6m56s skynet sha256.ca90... 9m37s

NAMESPACE NAME AGE default sha256.ca90... 6m56s skynet sha256.ca90... 9m37sCopy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: 特定の脆弱性の詳細を表示するには、特定の脆弱性とその namespace を特定し、

oc describeコマンドを使用します。以下の例は、イメージに脆弱性のある RPM パッケージが含まれるアクティブなコンテナーを示しています。oc describe vuln --namespace <namespace> sha256.ac50e3752...

$ oc describe vuln --namespace <namespace> sha256.ac50e3752...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

9.3. Container Security Operator のアンインストール

OpenShift Container Platform デプロイメントから Container Security Operator をアンインストールするには、Operator をアンインストールし、imagemanifestvulns.secscan.quay.redhat.com カスタムリソース定義 (CRD) を削除する必要があります。CRD を削除しないと、OpenShift Container Platform の Overview ページでイメージの脆弱性が引き続き報告されます。

手順

- OpenShift Container Platform Web コンソールで、Operators → Installed Operators をクリックします。

- Container Security Operator のケバブメニューをクリックします。

- Uninstall Operator をクリックします。ポップアップウィンドウで Uninstall をクリックして、決定を確認します。

次のコマンドを入力して、

imagemanifestvulns.secscan.quay.redhat.comカスタムリソース定義を削除します。oc delete customresourcedefinition imagemanifestvulns.secscan.quay.redhat.com

$ oc delete customresourcedefinition imagemanifestvulns.secscan.quay.redhat.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

customresourcedefinition.apiextensions.k8s.io "imagemanifestvulns.secscan.quay.redhat.com" deleted

customresourcedefinition.apiextensions.k8s.io "imagemanifestvulns.secscan.quay.redhat.com" deletedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第10章 AWS STS for Red Hat Quay の設定

Amazon Web Services (AWS) Security Token Service (STS) のサポートは、スタンドアロンの Red Hat Quay デプロイメント、Red Hat Quay on OpenShift Container Platform、および Red Hat OpenShift Service on AWS (ROSA) で利用できます。AWS STS は、AWS アイデンティティーおよびアクセス管理 (IAM) ユーザー、認証したユーザー、または フェデレーションユーザー に対して、一時的な制限付き権限の認証情報をリクエストするための Web サービスです。この機能は、Amazon S3 をオブジェクトストレージとして使用するクラスターに役立ち、Red Hat Quay は STS プロトコルを使用して Amazon S3 で認証できます。これにより、クラスターの全体的なセキュリティーが強化され、機密データへのアクセスが適切に認証および承認される際に役立ちます。

OpenShift Container Platform または ROSA 用に AWS STS を設定するには、AWS IAM ユーザーを作成し、S3 ロールを作成し、適切なリソースを含めるように Red Hat Quay config.yaml ファイルを設定する必要があります。

AWS STS for Red Hat Quay を設定するには、次の手順に従います。

10.1. IAM ユーザーの作成

Identity and Access Management (IAM) ユーザーを作成するには、次の手順に従います。

手順

- Amazon Web Services (AWS) コンソールにログインし、アイデンティティーおよびアクセス管理 (IAM) コンソールに移動します。

- ナビゲーションウィンドウの Access management で Users をクリックします。

Create User をクリックし、以下の情報を入力します。

-

有効なユーザー名 (例:

quay-user) を入力します。 - Permissions options の場合は、Add user to group をクリックします。

-

有効なユーザー名 (例:

- review and create ページで、Create user をクリックします。Users ページにリダイレクトされます。

- ユーザー名 (例: quay-user) をクリックします。

-

ユーザーの ARN をコピーします (例:

arn:aws:iam::123456:user/quay-user)。 - 同じページで、Security credentials タブをクリックします。

- Access keys に移動します。

- Create access key をクリックします。

- Access key best practices & alternatives ページで、Command Line Interface (CLI) をクリックしてから、確認ボックスをオンにします。Next をクリックします。

- オプション: Set description tag - optional ページで、説明を入力します。

- Create access key をクリックします。

アクセスキーとシークレットアクセスキーをコピーして保存します。

重要シークレットアクセスキーを表示またはダウンロードできるのは、このときだけです。後でこれを実行することはできません。ただし、新しいアクセスキーはいつでも作成できます。

- Done をクリックします。

10.2. S3 ロールの作成

次の手順を使用して、AWS STS の S3 ロールを作成します。

前提条件

- IAM ユーザーが作成され、アクセスキーとシークレットアクセスキーが保存されている。

手順

- IAM ダッシュボードに移動します。

- ナビゲーションペインで、Access management の下の Roles をクリックします。

- Create role → Custom Trust Policy をクリックします。

Principal設定フィールドに、AWS ARN 情報を追加します。以下に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Next をクリックします。

-

Add permissions ページで、検索ボックスに

AmazonS3FullAccessと入力します。チェックボックスをオンにしてそのポリシーを S3 ロールに追加し、Next をクリックします。 Name, review, and create ページで、次の情報を入力します。

-

ロール名を入力します (例:

example-role)。 - オプション: 説明を追加します。

-

ロール名を入力します (例: