This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.개발자 가이드

OpenShift Container Platform 3.9 개발자 참조

초록

1장. 개요

이 안내서는 애플리케이션 개발자를 대상으로 하며 OpenShift Container Platform 클라우드 환경에서 애플리케이션을 개발하고 배포하기 위해 워크스테이션을 설정하고 구성하기 위한 지침을 제공합니다. 여기에는 개발자를 위한 자세한 지침 및 예제가 포함됩니다.

2장. 애플리케이션 라이프 사이클 관리

2.1. 개발 프로세스 계획

2.1.1. 개요

OpenShift Container Platform은 애플리케이션을 빌드하고 배포하기 위해 설계되었습니다. 개발 프로세스에서 OpenShift Container Platform을 포함하려는 기간에 따라 다음을 선택할 수 있습니다.

- OpenShift Container Platform 프로젝트 내에서 개발에 중점을 두어 처음부터 애플리케이션을 빌드한 다음 라이프사이클을 지속적으로 개발 및 관리하거나

- 별도의 환경에서 이미 개발한 애플리케이션(예: 바이너리, 컨테이너 이미지, 소스 코드)을 가져와 OpenShift Container Platform에 배포합니다.

2.1.2. OpenShift Container Platform을 개발 환경으로 사용

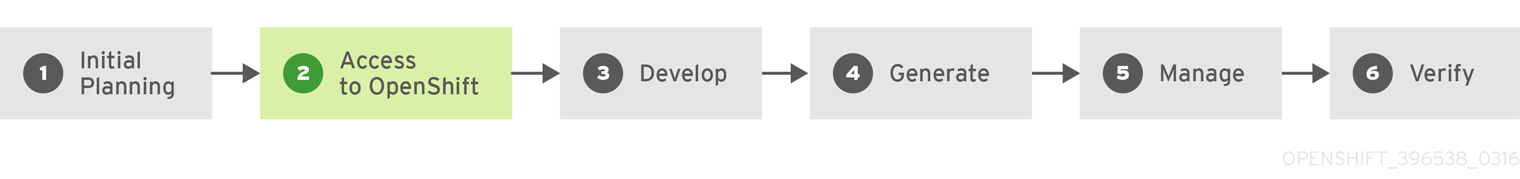

OpenShift Container Platform을 직접 사용하여 애플리케이션 개발을 처음부터 시작할 수 있습니다. 이러한 유형의 개발 프로세스를 계획할 때 다음 단계를 고려하십시오.

초기 계획

- 사용 중인 애플리케이션은 어떻게 합니까?

- 어떤 프로그래밍 언어를 개발할 수 있습니까?

OpenShift Container Platform 액세스

- OpenShift Container Platform은 귀하 또는 조직 내 관리자가 이 시점에 설치해야 합니다.

개발

- 선택한 편집기 또는 IDE를 사용하여 애플리케이션의 기본 스keleton을 만듭니다. OpenShift Container Platform에 어떤 종류의 애플리케이션인지 알 수 있을 만큼 충분히 개발되어야 합니다.

- 코드를 Git 리포지토리로 내보냅니다.

generate

-

oc new-app명령을 사용하여 기본 애플리케이션을 만듭니다. OpenShift Container Platform은 빌드 및 배포 구성을 생성합니다.

관리

- 애플리케이션 코드 개발을 시작합니다.

- 애플리케이션 빌드가 완료되었는지 확인합니다.

- 로컬 개발 및 코드 단축으로 계속 진행하십시오.

- 코드를 Git 리포지토리로 내보냅니다.

- 추가 구성이 필요합니까? 자세한 옵션은 개발자 가이드 를 참조하십시오.

확인

-

여러 가지 방법으로 애플리케이션을 확인할 수 있습니다. 변경 사항을 애플리케이션의 Git 리포지토리로 푸시하고 OpenShift Container Platform을 사용하여 애플리케이션을 다시 빌드하고 재배포할 수 있습니다. 또는

rsync를 사용하여 핫 디플로이먼트를 통해 코드 변경 사항을 실행 중인 Pod에 동기화할 수 있습니다.

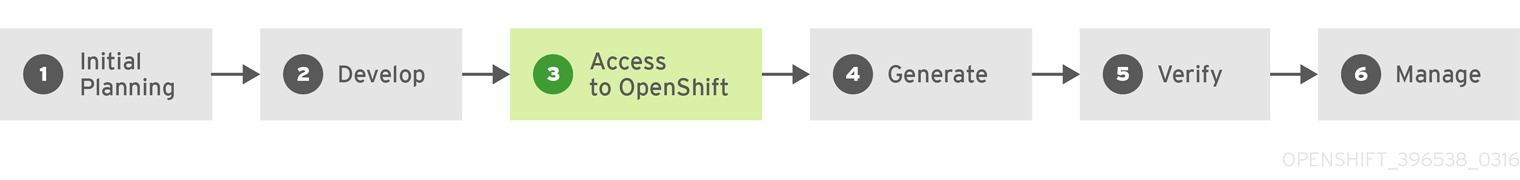

2.1.3. OpenShift Container Platform에 배포할 애플리케이션 가져오기

또 다른 가능한 애플리케이션 개발 전략은 로컬에서 개발한 다음 OpenShift Container Platform을 사용하여 완전히 개발한 애플리케이션을 배포하는 것입니다. 애플리케이션 코드가 이미 애플리케이션 코드가 있는 경우 다음 프로세스를 사용하여 OpenShift Container Platform 설치에 빌드 및 배포하려는 경우 완료 시 다음을 수행합니다.

초기 계획

- 사용 중인 애플리케이션은 어떻게 합니까?

- 어떤 프로그래밍 언어를 개발할 수 있습니까?

개발

- 선택한 편집기 또는 IDE를 사용하여 애플리케이션 코드를 개발합니다.

- 로컬로 애플리케이션 코드를 빌드하고 테스트합니다.

- 코드를 Git 리포지토리로 내보냅니다.

OpenShift Container Platform 액세스

- OpenShift Container Platform은 귀하 또는 조직 내 관리자가 이 시점에 설치해야 합니다.

generate

-

oc new-app명령을 사용하여 기본 애플리케이션을 만듭니다. OpenShift Container Platform은 빌드 및 배포 구성을 생성합니다.

확인

- 위의 Generate 단계에 빌드 및 배포한 애플리케이션이 OpenShift Container Platform에서 성공적으로 실행되고 있는지 확인합니다.

관리

- 결과에 만족할 때까지 애플리케이션 코드를 계속 개발하십시오.

- OpenShift Container Platform에서 애플리케이션을 다시 빌드하여 새로 내보낸 코드를 수락합니다.

- 추가 구성이 필요합니까? 자세한 옵션은 개발자 가이드 를 참조하십시오.

2.2. 새 애플리케이션 생성

2.2.1. 개요

OpenShift CLI 또는 웹 콘솔을 사용하여 소스 또는 바이너리 코드, 이미지 및/또는 템플릿을 포함한 구성 요소에서 새 OpenShift Container Platform 애플리케이션을 생성할 수 있습니다.

2.2.2. CLI를 사용하여 애플리케이션 생성

2.2.2.1. 소스 코드에서 애플리케이션 생성

new-app 명령을 사용하면 로컬 또는 원격 Git 리포지토리의 소스 코드에서 애플리케이션을 생성할 수 있습니다.

로컬 디렉터리에서 Git 리포지토리를 사용하여 애플리케이션을 생성하려면 다음을 수행합니다.

oc new-app /path/to/source/code

$ oc new-app /path/to/source/code

로컬 Git 리포지토리를 사용하는 경우 리포지토리에 OpenShift Container Platform 클러스터에서 액세스할 수 있는 URL을 가리키는 origin 이라는 원격이 있어야 합니다. 리모트가 없는 경우 new-app 은 바이너리 빌드 를 생성합니다.

원격 Git 리포지토리를 사용하여 애플리케이션을 생성하려면 다음을 수행합니다.

oc new-app https://github.com/sclorg/cakephp-ex

$ oc new-app https://github.com/sclorg/cakephp-ex프라이빗 원격 Git 리포지토리를 사용하여 애플리케이션을 생성하려면 다음을 수행합니다.

oc new-app https://github.com/youruser/yourprivaterepo --source-secret=yoursecret

$ oc new-app https://github.com/youruser/yourprivaterepo --source-secret=yoursecret

프라이빗 원격 Git 리포지토리를 사용하는 경우 --source-secret 플래그를 사용하여 BuildConfig 에 삽입할 기존 소스 복제 보안을 지정하여 리포지토리에 액세스할 수 있습니다.

--context-dir 플래그를 지정하여 소스 코드 리포지토리의 하위 디렉터리를 사용할 수 있습니다. 원격 Git 리포지토리 및 컨텍스트 하위 디렉터리를 사용하여 애플리케이션을 생성하려면 다음을 수행합니다.

oc new-app https://github.com/sclorg/s2i-ruby-container.git \

--context-dir=2.0/test/puma-test-app

$ oc new-app https://github.com/sclorg/s2i-ruby-container.git \

--context-dir=2.0/test/puma-test-app

또한 원격 URL을 지정하면 URL 끝에 #<branch_name>을 추가하여 사용할 Git 분기를 지정할 수 있습니다.

oc new-app https://github.com/openshift/ruby-hello-world.git#beta4

$ oc new-app https://github.com/openshift/ruby-hello-world.git#beta4

new-app 명령은 소스 코드에서 자체적으로 새 애플리케이션 이미지를 생성하는 빌드 구성을 생성합니다. new-app 명령은 일반적으로 새 이미지를 배포하는 배포 구성 과 이미지를 실행하는 배포에 부하 분산 액세스를 제공하는 서비스를 생성합니다.

OpenShift Container Platform은 Docker, Pipeline 또는 Source 빌드 전략 사용 여부를 자동으로 탐지 하고 Source 빌드의 경우 적절한 언어 빌더 이미지를 탐지합니다.

빌드 전략 탐지

새 애플리케이션을 생성할 때 Jenkinsfile 이 소스 리포지토리의 루트 또는 지정된 컨텍스트 디렉터리에 있는 경우 OpenShift Container Platform은 Pipeline 빌드 전략을 생성합니다. 그렇지 않으면 Dockerfile 이 발견되면 OpenShift Container Platform에서 Docker 빌드 전략을 생성합니다. 그렇지 않으면 소스 빌드 전략을 생성합니다.

--strategy 플래그를 docker,pipeline 또는 source 로 설정하여 빌드 전략을 덮어쓸 수 있습니다.

oc new-app /home/user/code/myapp --strategy=docker

$ oc new-app /home/user/code/myapp --strategy=docker

oc 명령을 실행하려면 빌드 소스가 포함된 파일이 원격 Git 리포지토리에 제공되어야 합니다. 모든 소스 빌드에 git remote -v를 사용해야 합니다.

언어 탐지

Source 빌드 전략을 사용하는 경우 new-app 은 리포지토리의 루트 또는 지정된 컨텍스트 디렉터리에 특정 파일이 있는지에 따라 사용할 언어 빌더를 결정합니다.

| 언어 | 파일 |

|---|---|

|

| project.json, *.csproj |

|

| pom.xml |

|

| app.json, package.json |

|

| cpanfile, index.pl |

|

| composer.json, index.php |

|

| requirements.txt, setup.py |

|

| Gemfile, Rakefile, config.ru |

|

| build.sbt |

|

| Godeps, main.go |

언어를 탐지한 후 new-app 은 OpenShift Container Platform 서버에서 탐지된 언어와 일치하는 supports 주석이 있는 이미지 스트림 태그 또는 탐지된 언어의 이름과 일치하는 이미지 스트림을 검색합니다. 일치 항목이 없는 경우 new-app은 Docker Hub 레지스트리에서 이름을 기반으로 탐지된 언어와 일치하는 이미지를 검색합니다.

이미지(이미지 스트림 또는 컨테이너 사양)와 리포지토리를 지정하여 빌더에서 특정 소스 리포지토리에 사용하는 이미지를 재정의할 수 있습니다. 이 작업이 완료되면 빌드 전략 탐지 및 언어 탐지 가 수행되지 않습니다.

예를 들어 원격 리포지토리의 소스에 myproject/my-ruby 이미지 스트림을 사용하려면 다음을 실행합니다.

oc new-app myproject/my-ruby~https://github.com/openshift/ruby-hello-world.git

$ oc new-app myproject/my-ruby~https://github.com/openshift/ruby-hello-world.git로컬 리포지토리의 소스에 openshift/ruby-20-centos7:latest 컨테이너 이미지 스트림을 사용하려면 다음을 수행합니다.

oc new-app openshift/ruby-20-centos7:latest~/home/user/code/my-ruby-app

$ oc new-app openshift/ruby-20-centos7:latest~/home/user/code/my-ruby-app2.2.2.2. 이미지에서 애플리케이션 생성

기존 이미지에서 애플리케이션을 배포할 수 있습니다. 이미지는 OpenShift Container Platform 서버의 이미지 스트림, 특정 레지스트리 또는 Docker Hub 레지스트리의 이미지 또는 로컬 Docker 서버의 이미지에서 가져올 수 있습니다.

new-app 명령은 전달된 인수에 지정된 이미지 유형을 확인합니다. 그러나 이미지가 Docker 이미지인지( -i| 인수를 사용하여) 이미지 스트림인지 --image new-app 에 명시적으로 알릴 수 있습니다.

로컬 Docker 리포지토리에서 이미지를 지정하는 경우 OpenShift Container Platform 클러스터 노드에서 동일한 이미지를 사용할 수 있는지 확인해야 합니다.

예를 들어 DockerHub MySQL 이미지에서 애플리케이션을 생성하려면 다음을 수행합니다.

oc new-app mysql

$ oc new-app mysql프라이빗 레지스트리의 이미지를 사용하여 애플리케이션을 생성하려면 전체 Docker 이미지 사양을 지정합니다.

oc new-app myregistry:5000/example/myimage

$ oc new-app myregistry:5000/example/myimage

이미지가 포함된 레지스트리가 SSL로 보호되지 않은 경우 클러스터 관리자는 해당 레지스트리를 가리키는 --insecure-registry 플래그로 OpenShift Container Platform 노드 호스트의 Docker 데몬을 실행해야 합니다. 또한 new-app 에 --insecure-registry 플래그가 있는 비보안 레지스트리에서 이미지가 제공되도록 해야 합니다.

기존 이미지 스트림 및 선택적 이미지 스트림 태그 에서 애플리케이션을 생성할 수 있습니다.

oc new-app my-stream:v1

$ oc new-app my-stream:v12.2.2.3. 템플릿에서 애플리케이션 생성

템플릿 이름을 인수로 지정하여 이전에 저장된 템플릿 또는 템플릿 파일에서 애플리케이션을 생성할 수 있습니다. 예를 들어 샘플 애플리케이션 템플릿을 저장하고 이를 사용하여 애플리케이션을 생성할 수 있습니다.

저장된 템플릿에서 애플리케이션을 생성하려면 다음을 수행합니다.

oc create -f examples/sample-app/application-template-stibuild.json oc new-app ruby-helloworld-sample

$ oc create -f examples/sample-app/application-template-stibuild.json

$ oc new-app ruby-helloworld-sample

OpenShift Container Platform에 먼저 저장하지 않고 로컬 파일 시스템에서 템플릿을 직접 사용하려면 -f|--file 인수를 사용합니다.

oc new-app -f examples/sample-app/application-template-stibuild.json

$ oc new-app -f examples/sample-app/application-template-stibuild.json템플릿 매개변수

템플릿을 기반으로 애플리케이션을 생성할 때 -p|--param 인수를 사용하여 템플릿에 정의된 매개변수 값을 설정합니다.

oc new-app ruby-helloworld-sample \

-p ADMIN_USERNAME=admin -p ADMIN_PASSWORD=mypassword

$ oc new-app ruby-helloworld-sample \

-p ADMIN_USERNAME=admin -p ADMIN_PASSWORD=mypassword

템플릿을 인스턴스화할 때 해당 매개변수를 파일에 저장한 다음 해당 파일을 --param-file과 함께 사용할 수 있습니다. 표준 입력에서 매개변수를 읽으려면 --param-file=-:을 사용하십시오.

cat helloworld.params ADMIN_USERNAME=admin ADMIN_PASSWORD=mypassword $ oc new-app ruby-helloworld-sample --param-file=helloworld.params $ cat helloworld.params | oc new-app ruby-helloworld-sample --param-file=-

$ cat helloworld.params

ADMIN_USERNAME=admin

ADMIN_PASSWORD=mypassword

$ oc new-app ruby-helloworld-sample --param-file=helloworld.params

$ cat helloworld.params | oc new-app ruby-helloworld-sample --param-file=-2.2.2.4. 애플리케이션 생성 추가 수정

new-app 명령은 생성 중인 애플리케이션을 빌드, 배포, 실행할 OpenShift Container Platform 오브젝트를 생성합니다. 일반적으로 이러한 오브젝트는 입력 소스 리포지토리 또는 입력 이미지에서 파생된 이름을 사용하여 현재 프로젝트에서 생성됩니다. 그러나 new-app 을 사용하면 이 동작을 수정할 수 있습니다.

new-app으로 생성되는 오브젝트 세트는 입력을 통해 전달되는 아티팩트(소스 리포지토리, 이미지 또는 템플릿)에 따라 다릅니다.

| 개체 | 설명 |

|---|---|

|

|

명령줄에 지정된 각 소스 리포지토리에 대해 |

|

|

|

|

|

|

|

|

|

| 기타 | 기타 오브젝트는 템플릿에 따라 템플릿을 인스턴스화할 때 생성될 수 있습니다. |

2.2.2.4.1. 환경 변수 지정

템플릿,소스 또는 이미지에서 애플리케이션을 생성할 때 -e|--env 인수를 사용하여 런타임 시 환경 변수를 애플리케이션 컨테이너에 전달할 수 있습니다.

oc new-app openshift/postgresql-92-centos7 \

-e POSTGRESQL_USER=user \

-e POSTGRESQL_DATABASE=db \

-e POSTGRESQL_PASSWORD=password

$ oc new-app openshift/postgresql-92-centos7 \

-e POSTGRESQL_USER=user \

-e POSTGRESQL_DATABASE=db \

-e POSTGRESQL_PASSWORD=password

이 변수는 --env-file 인수를 사용하여 파일에서 읽을 수도 있습니다.

cat postgresql.env POSTGRESQL_USER=user POSTGRESQL_DATABASE=db POSTGRESQL_PASSWORD=password $ oc new-app openshift/postgresql-92-centos7 --env-file=postgresql.env

$ cat postgresql.env

POSTGRESQL_USER=user

POSTGRESQL_DATABASE=db

POSTGRESQL_PASSWORD=password

$ oc new-app openshift/postgresql-92-centos7 --env-file=postgresql.env

또한 --env-file=-을 사용하여 환경 변수를 표준 입력에 제공할 수 있습니다.

cat postgresql.env | oc new-app openshift/postgresql-92-centos7 --env-file=-

$ cat postgresql.env | oc new-app openshift/postgresql-92-centos7 --env-file=-자세한 내용은 환경 변수 관리를 참조하십시오.

new-app 처리의 일부로 생성된 BuildConfig 오브젝트는 -e|--env 또는 --env-file 인수를 통해 전달되는 환경 변수로 업데이트되지 않습니다.

2.2.2.4.2. 빌드 환경 변수 지정

템플릿,소스 또는 이미지에서 애플리케이션을 생성할 때 --build-env 인수를 사용하여 런타임 시 환경 변수를 빌드 컨테이너에 전달할 수 있습니다.

oc new-app openshift/ruby-23-centos7 \

--build-env HTTP_PROXY=http://myproxy.net:1337/ \

--build-env GEM_HOME=~/.gem

$ oc new-app openshift/ruby-23-centos7 \

--build-env HTTP_PROXY=http://myproxy.net:1337/ \

--build-env GEM_HOME=~/.gem

이 변수는 --build-env-file 인수를 사용하여 파일에서 읽을 수도 있습니다.

cat ruby.env HTTP_PROXY=http://myproxy.net:1337/ GEM_HOME=~/.gem $ oc new-app openshift/ruby-23-centos7 --build-env-file=ruby.env

$ cat ruby.env

HTTP_PROXY=http://myproxy.net:1337/

GEM_HOME=~/.gem

$ oc new-app openshift/ruby-23-centos7 --build-env-file=ruby.env

또한 --build-env-file=-을 사용하여 환경 변수를 표준 입력에 제공할 수 있습니다.

cat ruby.env | oc new-app openshift/ruby-23-centos7 --build-env-file=-

$ cat ruby.env | oc new-app openshift/ruby-23-centos7 --build-env-file=-2.2.2.4.3. 라벨 지정

소스,이미지 또는 템플릿에서 애플리케이션을 생성할 때 -l|--label 인수를 사용하여 생성된 오브젝트에 라벨을 추가할 수 있습니다. 라벨을 사용하면 애플리케이션과 관련된 오브젝트를 전체적으로 선택, 구성, 삭제할 수 있습니다.

oc new-app https://github.com/openshift/ruby-hello-world -l name=hello-world

$ oc new-app https://github.com/openshift/ruby-hello-world -l name=hello-world2.2.2.4.4. 생성 없이 출력 보기

new-app 이 생성되는 시험 실행을 보려면 yaml 또는 json 값과 함께 -o|--output 인수를 사용하면 됩니다. 그런 다음 출력을 사용하여 생성할 오브젝트를 미리 보거나 편집할 수 있는 파일로 리디렉션할 수 있습니다. 충족되면 oc create 를 사용하여 OpenShift Container Platform 오브젝트를 생성할 수 있습니다.

new-app 아티팩트를 파일에 출력하려면 편집하여 다음을 생성합니다.

oc new-app https://github.com/openshift/ruby-hello-world \

-o yaml > myapp.yaml

vi myapp.yaml

oc create -f myapp.yaml

$ oc new-app https://github.com/openshift/ruby-hello-world \

-o yaml > myapp.yaml

$ vi myapp.yaml

$ oc create -f myapp.yaml2.2.2.4.5. 다른 이름으로 오브젝트 생성

new-app으로 생성한 오브젝트는 일반적으로 소스 리포지토리 또는 해당 오브젝트를 생성하는 데 사용된 이미지의 이름을 따서 이름이 지정됩니다. 명령에 --name 플래그를 추가하여 생성한 오브젝트의 이름을 설정할 수 있습니다.

oc new-app https://github.com/openshift/ruby-hello-world --name=myapp

$ oc new-app https://github.com/openshift/ruby-hello-world --name=myapp2.2.2.4.6. 다른 프로젝트에서 오브젝트 생성

일반적으로 new-app은 현재 프로젝트에서 오브젝트를 생성합니다. 그러나 -n|--namespace 인수를 사용하여 액세스할 수 있는 다른 프로젝트에서 오브젝트를 생성할 수 있습니다.

oc new-app https://github.com/openshift/ruby-hello-world -n myproject

$ oc new-app https://github.com/openshift/ruby-hello-world -n myproject2.2.2.4.7. 여러 오브젝트 생성

new-app 명령을 사용하면 new-app에 다양한 매개변수를 지정하는 애플리케이션을 여러 개 생성할 수 있습니다. 명령 줄에서 지정된 라벨은 단일 명령으로 생성된 모든 개체에 적용됩니다. 환경 변수는 소스 또는 이미지에서 생성한 모든 구성 요소에 적용됩니다.

소스 리포지토리 및 Docker Hub 이미지에서 애플리케이션을 생성하려면 다음을 실행합니다.

oc new-app https://github.com/openshift/ruby-hello-world mysql

$ oc new-app https://github.com/openshift/ruby-hello-world mysql

소스 코드 리포지토리와 빌더 이미지가 별도의 인수로 지정되면 new-app에서 빌더 이미지를 소스 코드 저장소의 빌더로 사용합니다. 이를 원하지 않는 경우 ~ 구분자를 사용하여 소스에 필요한 빌더 이미지를 지정합니다.

2.2.2.4.8. 단일 Pod에서 이미지 및 소스 그룹화

new-app 명령을 사용하면 단일 Pod에 여러 이미지를 함께 배포할 수 있습니다. 함께 그룹화할 이미지를 지정하려면 + 구분자를 사용합니다. --group 명령줄 인수를 사용하여 함께 그룹화해야 하는 이미지를 지정할 수도 있습니다. 소스 리포지토리에서 빌드한 이미지를 기타 이미지와 함께 그룹화하려면 그룹에 해당 빌더 이미지를 지정합니다.

oc new-app ruby+mysql

$ oc new-app ruby+mysql소스에서 빌드한 이미지를 외부 이미지와 함께 배포하려면 다음을 실행합니다.

oc new-app \

ruby~https://github.com/openshift/ruby-hello-world \

mysql \

--group=ruby+mysql

$ oc new-app \

ruby~https://github.com/openshift/ruby-hello-world \

mysql \

--group=ruby+mysql2.2.2.4.9. 이미지, 템플릿 및 기타 입력 검색

oc new-app 명령에 대한 이미지, 템플릿 및 기타 입력을 검색하려면 --search 및 --list플래그를 추가합니다. 예를 들어 PHP를 포함하는 모든 이미지 또는 템플릿을 찾으려면 다음을 실행합니다.

oc new-app --search php

$ oc new-app --search php2.2.3. 웹 콘솔을 사용하여 애플리케이션 생성

2.3. 환경 간 애플리케이션 승격

2.3.1. 개요

애플리케이션 승격은 다양한 런타임 환경을 통해 애플리케이션을 이동하는 것을 의미하며, 일반적으로 완성도가 증가하고 있습니다. 예를 들어, 애플리케이션은 개발 환경에서 시작한 다음, 프로덕션 환경으로 승격되기 전에 추가 테스트를 위해 스테이징 환경으로 승격될 수 있습니다. 애플리케이션에 변경 사항이 도입되면 변경 사항이 개발 과정에서 다시 시작되고 스테이지 및 프로덕션을 통해 확장됩니다.

현재 "애플리케이션"은 Java, Perl, Python 등으로 작성된 소스 코드 이상의 것입니다. 애플리케이션의 언어별 런타임에 대한 정적 웹 콘텐츠, 통합 스크립트 또는 관련 구성보다 더 많은 것입니다. 이러한 언어별 런타임에서 사용하는 애플리케이션 특정 아카이브보다 많습니다.

OpenShift Container Platform과 Kubernetes 및 Docker의 결합된 기반과 관련된 추가 애플리케이션 아티팩트에는 다음이 포함됩니다.

- 풍부한 메타데이터 및 관련 툴 세트가 있는 Docker 컨테이너 이미지.

- 애플리케이션 사용을 위해 컨테이너에 삽입되는 환경 변수 입니다.

API 오브젝트 (리소스 정의라고도 함, OpenShift Container Platform의 코어 개념)를 참조하십시오.

- 애플리케이션 사용을 위해 컨테이너에 삽입됩니다.

- OpenShift Container Platform에서 컨테이너 및 Pod를 관리하는 방법을 지정합니다.

OpenShift Container Platform에서 애플리케이션을 승격하는 방법을 설명할 때 이 주제는 다음과 같습니다.

- 애플리케이션 정의에 도입된 이러한 새 아티팩트를 자세히 설명합니다.

- 애플리케이션 승격 파이프라인을 위해 다양한 환경을 해독할 수 있는 방법을 설명합니다.

- 이러한 새로운 아티팩트를 관리하기 위한 방법론과 툴에 대해 논의합니다.

- 애플리케이션 승격에 다양한 개념, 구성, 방법론 및 툴을 적용하는 예제를 제공합니다.

2.3.2. 애플리케이션 구성 요소

2.3.2.1. API 오브젝트

OpenShift Container Platform 및 Kubernetes 리소스 정의(애플리케이션 인벤토리에 새로 도입된 항목)와 관련하여 애플리케이션 승격 주제를 고려할 때 이러한 API 오브젝트의 몇 가지 주요 설계 지점이 있습니다.

먼저 OpenShift Container Platform 문서 전체에서 강조 표시된 대로 모든 API 오브젝트를 JSON 또는 YAML을 통해 표현할 수 있으므로 기존 소스 제어 및 스크립팅을 통해 이러한 리소스 정의를 쉽게 관리할 수 있습니다.

또한 API 오브젝트는 원하는 시스템의 상태를 지정하는 오브젝트의 일부와 시스템의 상태 또는 현재 상태를 반영하는 기타 부분을 제공하도록 설계되었습니다. 이는 입력 및 출력으로 간주할 수 있습니다. 입력 부분은 JSON 또는 YAML로 표현되는 경우 특히 SCM(소스 제어 관리) 아티팩트로 자연스럽게 적용되는 항목입니다.

API 오브젝트의 입력 또는 사양 부분은 완전히 정적이거나 동적일 수 있으므로 템플릿 처리를 통한 변수 대체 가 인스턴스화할 때 가능합니다.

API 오브젝트와 관련된 이러한 포인트의 결과는 해당 표현식을 JSON 또는 YAML 파일로 사용하면 애플리케이션 구성을 코드로 처리할 수 있다는 것입니다.

거의 모든 API 오브젝트가 조직의 애플리케이션 아티팩트로 간주될 수 있습니다. 다음은 애플리케이션 배포 및 관리와 관련된 오브젝트입니다.

- BuildConfigs

-

이는 애플리케이션 승격과 관련하여 특별한 사례 리소스입니다.

BuildConfig는 확실히 애플리케이션의 일부이지만 특히 개발자 관점에서는BuildConfig가 파이프라인을 통해 승격되지 않습니다. 파이프라인을통해승격된(다른 항목과 함께) 이미지를 생성합니다. - 템플릿

-

애플리케이션 승격 측면에서

템플릿은 특히 매개 변수화 기능을 사용하여 지정된 스테이징 환경에서 리소스를 설정하기 위한 시작점 역할을 할 수 있습니다. 추가 복원 후 수정은 애플리케이션이 승격 파이프라인을 통해 이동하는 경우에도 매우 적용할 수 있습니다. 이에 대한 자세한 내용은 시나리오 및 예제 를 참조하십시오. - 라우트

-

이는

경로를 통해 애플리케이션 액세스의 다양한 단계에 대한 테스트로서 애플리케이션 승격 파이프라인에서 단계마다 다른 가장 일반적인 리소스입니다. 또한 수동 사양 또는 호스트 이름의 자동 생성과경로의 HTTP 수준 보안과 관련된 옵션이 있습니다. - 서비스

-

지정된 애플리케이션 승격 단계(빠른 단계에서 개별 개발자를 위해 간단하게 수행)에서 router 및

Routes를 방지하기 위한 이유가 있는 경우,ClusterIP 주소와 포트를 통해 애플리케이션에 액세스할 수 있습니다.사용되는 경우 단계 간 주소와 포트 관리를 일부 확인할 수 있습니다. - 끝점

-

특정 애플리케이션 수준 서비스(예: 많은 엔터프라이즈의 데이터베이스 인스턴스)는 OpenShift Container Platform에서 관리하지 않을 수 있습니다. 그런 다음 해당

엔드포인트를 직접 만든 다음 해당 엔드포인트를 직접 생성하는 경우(서비스의 선택기 필드 작성)는 중복되거나 단계 간에 공유되는 활동입니다(사용자 환경 위임 방법 기반). - 보안

-

시크릿에 의해 캡슐화된 민감한 정보는 해당 엔티티(OpenShift Container Platform에서 관리하는

서비스또는 OpenShift Container Platform 외부에서 관리되는 외부 서비스)가 공유하는 경우 스테이징 환경 간에 공유됩니다.애플리케이션 승격 파이프라인의 서로 다른 단계에 있는 엔터티의 다양한 버전이 있는 경우 파이프라인의 각 단계에서 고유한 보안을 유지하거나 파이프라인을 통과하면서 수정할 수 있습니다.또한 SCM에 JSON 또는 YAML로보안을 저장하는 경우 중요한 정보를 보호하기 위해 일종의 암호화가 보장될 수 있습니다. - DeploymentConfigs

- 이 오브젝트는 지정된 애플리케이션 승격 파이프라인 단계에 대한 환경을 정의하고 범위를 지정하는 데 필요한 기본 리소스입니다. 애플리케이션 시작 방법을 제어합니다. 모든 다른 단계에서 공통적인 측면이 있지만, 애플리케이션 승격 파이프라인을 통해 진행됨에 따라 각 단계의 환경의 차이를 반영하거나 애플리케이션의 다양한 시나리오 테스트를 용이하게 하기 위해 시스템 동작의 변화가 변경되어 있습니다.

- ImageStreams, ImageStreamTags, ImageStreamImage

- 이미지 및 이미지 스트림 섹션에 자세히 설명된 이러한 오브젝트는 컨테이너 이미지 관리에 대한 OpenShift Container Platform 추가의 핵심입니다. ???

- serviceaccounts 및 RoleBindings

-

OpenShift Container Platform 내의 다른 API 오브젝트와 외부 서비스에 대한 권한 관리는 애플리케이션을 관리하는 데 기본적으로 사용됩니다.

Secrets와 유사하게ServiceAccounts및RoleBindings오브젝트는 서로 다른 환경을 공유하거나 분리해야 하는 애플리케이션 승격 파이프라인의 다양한 단계 간에 공유되는 방법에 따라 다를 수 있습니다. - PersistentVolumeClaims

- 데이터베이스와 같은 상태 저장 서비스와 관련하여 서로 다른 애플리케이션 승격 단계 간에 공유하는 양과 조직이 애플리케이션 데이터의 사본을 공유하는 방법과 직접 관련이 있습니다.

- ConfigMaps

-

PodPod동작이 필요한 경우 다양한 스테이징 환경에서 공유할 수 있습니다.포드동작을 변경하기 위해 단계 간에 수정할 수도 있습니다(일반적으로 애플리케이션의 다양한 측면이 다른 단계에서 심사됨).

2.3.2.2. 이미지

앞에서 언급했듯이 컨테이너 이미지는 이제 애플리케이션의 아티팩트입니다. 사실, 새로운 애플리케이션 아티팩트를 통해 이미지와 이미지 관리는 애플리케이션 승격과 관련된 주요 요소입니다. 경우에 따라 이미지가 애플리케이션의 전체를 캡슐화할 수 있으며 애플리케이션 승격 흐름은 이미지 관리만으로 구성됩니다.

일반적으로 이미지는 애플리케이션 바이너리가 이전 시스템에 없는 것처럼 SCM 시스템에서 관리되지 않습니다. 그러나 바이너리, 설치 가능한 아티팩트 및 해당 리포지토리(즉, RPM 리포지토리, RPM 리포지토리, Nexus 등)와 마찬가지로 SCM과 유사한 이미지 관리, 유사한 구조 및 용어와 유사한 구조 및 용어가 발생합니다.

- 이미지 레지스트리 == SCM 서버

- 이미지 리포지토리 == SCM 리포지토리

이미지가 레지스트리에 있으므로 해당 이미지에서 나타내는 애플리케이션을 실행해야 하는 환경에서 액세스할 수 있는 레지스트리에 적절한 이미지가 있는지 확인하는 것과 관련된 애플리케이션 승격입니다.

이미지를 직접 참조하지 않고 애플리케이션 정의는 일반적으로 이미지 스트림에 대한 참조를 추상화합니다. 즉, 이미지 스트림은 애플리케이션 구성 요소를 구성하는 또 다른 API 오브젝트가 됩니다. 이미지 스트림에 대한 자세한 내용은 핵심 개념을 참조하십시오.

2.3.2.3. 요약

이제 OpenShift Container Platform 내에서 애플리케이션 승격과 관련된 참고 사항, 이미지 및 API 오브젝트의 애플리케이션 아티팩트에 자세히 설명되어 있습니다. 승격 파이프라인의 다양한 단계에서 애플리케이션을 실행하는 위치는 토론 지점 옆에 있습니다.

2.3.3. 배포 환경

이 컨텍스트에서 배포 환경은 CI/CD 파이프라인의 특정 단계에서 애플리케이션을 실행할 별도의 공간을 설명합니다. 일반적인 환경에는 개발,테스트,스테이지 및 프로덕션 등이 있습니다. 환경의 경계는 다음과 같은 다양한 방법으로 정의할 수 있습니다.

- 단일 프로젝트 내에서 레이블 및 고유한 이름 지정을 통해

- 클러스터 내의 다양한 프로젝트를 통해

- 별도의 클러스터를 통해.

그리고 귀하의 조직이 세 가지를 모두 활용할 수 있다고 생각할 수 있습니다.

2.3.3.1. 고려 사항

일반적으로 배포 환경을 구성하는 방법에 다음과 같은 추론을 고려합니다.

- 승격 흐름의 다양한 단계를 허용하는 리소스 양

- 승격 흐름의 다양한 단계를 얼마나 격리해야하는지

- 승격 흐름의 다양한 단계를 중앙에서 (또는 지리적으로 분산) 중앙 위치(또는 지리적으로 분산) 방법

또한 OpenShift Container Platform 클러스터 및 프로젝트가 이미지 레지스트리와 관련된 방법에 대한 몇 가지 중요한 알림은 다음과 같습니다.

- 동일한 클러스터의 여러 프로젝트에서 동일한 이미지 스트림에 액세스할 수 있습니다.

- 여러 클러스터가 동일한 외부 레지스트리에 액세스할 수 있습니다.

- 클러스터는 OpenShift Container Platform 내부 이미지 레지스트리가 경로를 통해 노출되는 경우에만 레지스트리를 공유할 수 있습니다.

2.3.3.2. 요약

배포 환경을 정의한 후에는 파이프라인 내에서 단계가 중단되는 승격 흐름을 구현할 수 있습니다. 이러한 승격 흐름 구현을 구성하는 방법과 도구는 다음 토론 포인트입니다.

2.3.4. 방법 및 도구

근본적으로 애플리케이션 승격은 앞서 언급한 애플리케이션 구성 요소를 한 환경에서 다른 환경으로 이동하는 프로세스입니다. 다음 하위 섹션에서는 애플리케이션 승격 자동화에 대한 전체적인 솔루션을 논의하기 전에 다양한 구성 요소를 직접 이동하는 데 사용할 수 있는 툴을 간략하게 설명합니다.

빌드 및 배포 프로세스 중 사용할 수 있는 삽입 지점이 많이 있습니다. BuildConfig 및 DeploymentConfig API 오브젝트 내에 정의됩니다. 이러한 후크를 사용하면 데이터베이스 및 OpenShift Container Platform 클러스터 자체와 같이 배포된 구성 요소와 상호 작용할 수 있는 사용자 정의 스크립트를 호출할 수 있습니다.

따라서 이러한 후크를 사용하여 환경 간에 애플리케이션을 효과적으로 이동하는 구성 요소 관리 작업을 수행할 수 있습니다. 예를 들어 후크 내에서 이미지 태그 작업을 수행할 수 있습니다. 그러나 다양한 후크 포인트는 특정 환경 내에서 애플리케이션의 라이프사이클을 관리하는 데 가장 적합합니다(예: 새 버전의 애플리케이션이 배포될 때 데이터베이스 스키마 마이그레이션을 수행하기 위해 사용) 환경 간에 애플리케이션 구성 요소를 이동하는 것이 좋습니다.

2.3.4.1. API 오브젝트 관리

하나의 환경에 정의된 대로 리소스는 새 환경으로 가져오기 위해 JSON 또는 YAML 파일 콘텐츠로 내보냅니다. 따라서 JSON 또는 YAML로 API 오브젝트의 표현식은 애플리케이션 파이프라인을 통해 API 오브젝트를 승격하는 작업 단위 역할을 합니다. oc CLI는 이 콘텐츠를 내보내고 가져오는 데 사용됩니다.

파일에 저장된 JSON 또는 YAML로 OpenShift Container Platform을 통한 승격 흐름에는 필요하지 않지만 SCM 시스템에서 콘텐츠를 저장하고 검색할 수 있습니다. 이를 통해 분기 생성, 다양한 라벨 또는 버전에 연결된 태그를 비롯하여 SCM의 버전 관리 관련 기능을 활용할 수 있습니다.

2.3.4.1.1. API 오브젝트 상태 내보내기

oc export 를 사용하여 API 오브젝트 사양을 캡처해야 합니다. 이 작업은 오브젝트 정의(예: 현재 네임스페이스 또는 할당된 IP 주소)에서 환경별 데이터를 제거하여 다른 환경에서 재생성할 수 있습니다(예: 오브젝트의 필터링되지 않은 상태를 출력하는 oc get 작업 제외).

라벨에 단일 작업에서 Pod 그룹을 선택하고 관리할 수 있으므로 API 오브젝트에서 레이블을 추가, 수정 또는 제거할 수 있는 oc 레이블 을 사용하면 승격 흐름을 위해 수집되는 오브젝트 집합을 구성하는 것으로 유용할 수 있습니다. 이를 통해 올바른 오브젝트 세트를 쉽게 내보낼 수 있으며, 레이블이 새 환경에서 오브젝트를 생성할 때 전달되므로 각 환경에서 애플리케이션 구성 요소를 보다 쉽게 관리할 수 있습니다.

API 오브젝트에는 종종 보안을 참조하는 DeploymentConfig 와 같은 참조가 포함되어 있습니다. 하나의 환경에서 다른 환경으로 API 오브젝트를 이동할 때 이러한 참조도 새 환경으로 이동해야 합니다.

마찬가지로 DeploymentConfig 와 같은 API 오브젝트에는 외부 레지스트리를 참조하는 ImageStreams 에 대한 참조가 포함되는 경우가 많습니다. 하나의 환경에서 다른 환경으로 API 오브젝트를 이동할 때 이러한 참조를 새 환경 내에서 확인할 수 있는지 확인해야 합니다. 즉, 참조를 확인할 수 있어야 하며 ImageStream 이 새 환경에서 액세스할 수 있는 레지스트리를 참조해야 합니다. 자세한 내용은 이미지 이동 및 프로모션 Caveats 를 참조하십시오.

2.3.4.1.2. API 오브젝트 상태 가져오기

2.3.4.1.2.1. 초기 생성

애플리케이션이 새 환경에 처음 소개되는 경우 API 오브젝트의 사양을 표시하고 oc create 를 실행하여 적절한 환경에서 애플리케이션을 생성하는 JSON 또는 YAML로 충분합니다. oc create 를 사용하는 경우 --save-config 옵션을 고려하십시오. 주석 목록에 있는 오브젝트에 구성 요소를 저장하면 나중에 oc apply 를 사용하여 오브젝트를 수정할 수 있습니다.

2.3.4.1.2.2. 반복적 수정

다양한 스테이징 환경이 초기에 설정되고, 승격 주기가 시작되고 애플리케이션이 스테이지에서 단계로 이동하면 애플리케이션의 일부인 API 오브젝트의 수정이 포함될 수 있습니다. 이러한 API 오브젝트의 변경 사항은 OpenShift Container Platform 시스템의 구성을 나타내기 때문에 가능합니다. 이러한 변경에 대한 동기는 다음과 같습니다.

- 스테이징 환경 간의 환경 차이점에 대한 회계입니다.

- 애플리케이션에서 지원하는 다양한 시나리오 확인.

oc CLI를 사용하여 API 오브젝트를 다음 단계의 환경으로 전송합니다. API 오브젝트를 수정하는 다양한 oc 명령 세트가 있지만 이 주제에서는 oc apply, which computes and applies differences between objects에 중점을 둡니다.

특히 oc apply 를 기존 오브젝트 정의와 함께 입력으로 사용하는 3방향 병합으로 볼 수 있습니다. 다음과 같은 3방향 병합을 수행합니다.

- 상기 명령 입력은, The input to the command,

- 상기 객체의 현재 버전, 및 The current version of the object, and

- 현재 오브젝트에 주석으로 저장된 최신 사용자 지정 오브젝트 정의입니다.

그런 다음 기존 오브젝트가 결과로 업데이트됩니다.

오브젝트가 소스와 대상 환경 간에 동일할 것으로 예상되는 경우와 같이 API 오브젝트의 추가 사용자 정의가 필요한 경우 와 같은 oc 명령을 사용하여 업스트림 환경의 최신 오브젝트 정의를 적용한 후 오브젝트를 수정할 수 있습니다.

oc set

몇 가지 구체적인 사용은 시나리오와 예에 인용되어 있습니다.

2.3.4.2. 이미지 및 이미지 스트림 관리

OpenShift Container Platform의 이미지는 일련의 API 오브젝트를 통해 관리됩니다. 그러나 이미지 관리는 이미지에 가장 직접적으로 연결된 도구 및 API 오브젝트에 대한 토론을 애플리케이션 승격의 핵심입니다. 이미지 승격(파이프론을 통해 이미지 승격)을 관리하는 데 도움이 되는 수동 및 자동 양식이 모두 존재합니다.

2.3.4.2.1. 이미지 이동

이미지 관리와 관련된 자세한 경고 사항은 이미지 관리 주제를 참조하십시오.

2.3.4.2.1.2. 태그 환경에서 다른 레지스트리를 사용하는 경우

스테이징 환경에서 다른 OpenShift Container Platform 레지스트리를 사용하는 경우 고급 사용량이 발생합니다. 내부 레지스트리에 액세스하는 단계는 자세히 나와지만 요약하면 다음과 같습니다.

-

docker로그인 명령에 제공할 OpenShift Container Platform 액세스 토큰을 가져오는 docker명령을 사용합니다. -

OpenShift Container Platform 레지스트리에 로그인한 후

docker pull,docker tag및docker push를 사용하여 이미지를 전송합니다. -

다음 파이프라인 환경의 레지스트리에서 이미지를 사용할 수 있는 후 필요에 따라

oc tag를 사용하여 이미지 스트림을 채웁니다.

2.3.4.2.2. 배포

기본 애플리케이션 이미지 또는 애플리케이션을 구성하는 API 오브젝트를 변경하든 관계없이 승격된 변경 사항을 가져오기 위해 일반적으로 배포가 필요합니다. 애플리케이션 이미지가 변경되는 경우(예: 업스트림 환경에서 이미지를 승격하는 과정의 일부로 oc tag 작업 또는 docker push 로 인해) DeploymentConfig 의 ImageChangeTriggers 가 새 배포를 트리거할 수 있습니다. 마찬가지로 DeploymentConfig API 오브젝트 자체를 변경하는 경우 ConfigChangeTrigger 는 승격 단계에서 API 오브젝트를 업데이트할 때(예: oc apply) 배포를 시작할 수 있습니다.

그러지 않으면 수동 배포를 용이하게 하는 oc 명령은 다음과 같습니다.

-

oc rollout: 일시 중지 및 의미 체계를 다시 시작하고 기록 관리에 대한 풍부한 기능을 포함하여 배포를 관리하는 새로운 접근 방식입니다. -

oc rollback: 이전 배포로 되돌릴 수 있습니다. 승격 시나리오에서 새 버전 테스트에 문제가 발생하면 이전 버전과 함께 여전히 작동하는지 확인할 수 있습니다.

2.3.4.2.3. Jenkins를 사용하여 승격 흐름 자동화

승격 시 환경 간에 이동해야 하는 애플리케이션의 구성 요소와 구성 요소를 이동하는 데 필요한 단계를 이해한 후 워크플로를 오케스트레이션하고 자동화할 수 있습니다. OpenShift Container Platform은 이 프로세스에 도움이 되는 Jenkins 이미지 및 플러그인을 제공합니다.

OpenShift Container Platform Jenkins 이미지는 Jenkins 및 Jenkins 파이프라인의 통합을 용이하게 하는 OpenShift Container Platform 중심 플러그인 세트를 포함하여 이미지 사용을 자세히 설명합니다. 또한 Pipeline 빌드 전략은 Jenkins Pipelines와 OpenShift Container Platform 간의 통합을 지원합니다. 이러한 모든 초점은 애플리케이션 프로모션을 포함하여 CI/CD의 다양한 측면을 지원하는 데 중점을 둡니다.

애플리케이션 승격 단계의 수동 실행 이상으로 이동할 때 OpenShift Container Platform에서 제공하는 Jenkins 관련 기능을 염두에 두어야 합니다.

- OpenShift Container Platform은 OpenShift Container Platform 클러스터에서 쉽게 배포할 수 있도록 사용자 지정된 Jenkins 이미지를 제공합니다.

- Jenkins 이미지에는 승격 워크플로 구현을 위한 구성 블록을 제공하는 OpenShift Pipeline 플러그인이 포함되어 있습니다. 이러한 빌드 블록에는 Jenkins 작업의 트리거와 이미지 스트림 변경, 해당 작업 내의 빌드 및 배포 트리거가 포함됩니다.

-

OpenShift Container Platform Jenkins 파이프라인 빌드 전략을 사용하는

BuildConfig는 Jenkinsfile 기반 Jenkins 파이프라인 작업을 실행할 수 있습니다. 파이프라인 작업은 Jenkins의 복잡한 승격 흐름을 위한 전략적 방향이며 OpenShift Pipeline 플러그인에서 제공하는 단계를 활용할 수 있습니다.

2.3.4.2.4. Egree Caveats

2.3.4.2.4.1. API 오브젝트 참조

API 오브젝트는 다른 오브젝트를 참조할 수 있습니다. 이 문제의 일반적인 사용은 이미지 스트림을 참조하는 DeploymentConfig 가 있지만 다른 참조 관계가 존재할 수도 있습니다.

한 환경에서 다른 환경으로 API 오브젝트를 복사할 때 대상 환경에서 여전히 모든 참조를 확인할 수 있어야 합니다. 고려해야 할 몇 가지 참조 시나리오가 있습니다.

- 이 참조는 프로젝트의 "로컬"입니다. 이 경우 참조된 오브젝트는 참조하는 오브젝트와 동일한 프로젝트에 있습니다. 일반적으로 올바른 작업은 참조된 오브젝트를 참조하는 오브젝트와 동일한 프로젝트의 대상 환경에 복사하는 것입니다.

이 참조는 다른 프로젝트의 오브젝트입니다. 이는 일반적으로 공유 프로젝트의 이미지 스트림을 여러 애플리케이션 프로젝트에서 사용하는 경우입니다( 이미지 관리참조). 이 경우 참조 오브젝트를 새 환경에 복사할 때 대상 환경에서 해결될 수 있도록 필요에 따라 참조를 업데이트해야 합니다. 이는 다음을 의미할 수 있습니다.

- 대상 환경에서 공유 프로젝트의 이름이 다른 경우 참조를 가리키는 프로젝트를 변경합니다.

- 참조된 오브젝트를 대상 환경의 로컬 프로젝트로 이동하고 기본 오브젝트를 대상 환경으로 이동할 때 로컬 프로젝트를 가리키도록 참조를 업데이트합니다.

- 참조된 오브젝트를 대상 환경에 복사하고 참조 참조를 업데이트하는 다른 조합의 일부입니다.

일반적으로 지침은 새 환경에 복사 중인 개체에서 참조하는 오브젝트를 고려하고 대상 환경에서 참조를 확인할 수 있는지 확인하는 것입니다. 그렇지 않은 경우 참조를 수정하고 대상 환경에서 참조된 오브젝트를 사용할 수 있도록 적절한 조치를 취하십시오.

2.3.4.2.4.2. 이미지 레지스트리 참조

이미지 스트림은 이미지 리포지터리를 참조하여 표시되는 이미지의 소스를 나타냅니다. 이미지 스트림이 한 환경에서 다른 환경으로 이동하는 경우 레지스트리 및 리포지토리 참조도 변경해야 하는지 여부를 고려하는 것이 중요합니다.

- 다른 이미지 레지스트리를 사용하여 테스트 환경과 프로덕션 환경 간의 격리를 어설션합니다.

- 다른 이미지 리포지토리를 사용하여 테스트 및 프로덕션 지원 이미지를 분리합니다.

이러한 경우 올바른 이미지로 해석되도록 소스 환경에서 대상 환경으로 복사할 때 이미지 스트림을 수정해야 합니다. 이는 Scenarios 및 Examples에 설명된 단계를 수행하여 하나의 레지스트리와 저장소의 이미지를 다른 레지스트리로 복사하는 것도 가능합니다.

2.3.4.3. 요약

이 시점에서 다음이 정의됩니다.

- 배포된 애플리케이션을 구성하는 새 애플리케이션 아티팩트입니다.

- OpenShift Container Platform에서 제공하는 툴 및 개념과 애플리케이션 승격 활동에 대한 상관 관계입니다.

- OpenShift Container Platform과 CI/CD 파이프라인 엔진 Jenkins 간 통합

OpenShift Container Platform 내에서 애플리케이션 승격 흐름의 예를 함께 배치하는 것은 이 항목의 마지막 단계입니다.

2.3.5. 시나리오 및 예

Docker, Kubernetes 및 OpenShift Container Platform 에코시스템에서 도입한 새로운 애플리케이션 아티팩트 구성 요소를 정의하면 이 섹션에서는 OpenShift Container Platform에서 제공하는 메커니즘 및 툴을 사용하여 환경 간에 해당 구성 요소를 승격하는 방법을 설명합니다.

애플리케이션을 구성하는 구성 요소 중 이미지는 주 아티팩트입니다. 온프레미스를 가져와서 애플리케이션 승격으로 확장하는 경우 핵심, 기본 애플리케이션 승격 패턴은 이미지 승격입니다. 여기서 작업 단위가 이미지입니다. 대부분의 애플리케이션 프로모션 시나리오에는 승격 파이프라인을 통해 이미지를 관리하고 전파해야 합니다.

간단한 시나리오는 파이프라인을 통해 이미지를 관리하고 전파하기만 하면 됩니다. 승격 시나리오가 범위가 넓어짐에 따라 다른 애플리케이션 아티팩트(특히 API 오브젝트)가 파이프라인을 통해 관리되고 전파되는 항목에 포함됩니다.

이 주제에서는 수동 및 자동화된 접근 방식을 모두 사용하여 이미지를 승격하는 것과 API 오브젝트를 승격하는 몇 가지 구체적인 예제를 설명합니다. 먼저 애플리케이션 승격 파이프라인의 환경 설정에 다음을 유의하십시오.

2.3.5.1. 프로모션에 대한 설정

애플리케이션의 초기 버전 개발을 완료한 후 다음 논리적 단계는 승격 파이프라인의 후속 스테이징 환경으로 전송할 수 있도록 애플리케이션의 콘텐츠를 패키징하는 것입니다.

먼저 전송 가능으로 보는 모든 API 오브젝트를 그룹화하고 여기에 공통

라벨을적용합니다.labels: promotion-group: <application_name>

labels: promotion-group: <application_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 앞에서 설명한 대로

oc label명령은 다양한 API 오브젝트를 사용하여 라벨을 쉽게 관리할 수 있습니다.작은 정보OpenShift Container Platform 템플릿에서 처음에 API 오브젝트를 정의하는 경우 프로모션 준비를 위해 내보낼 때 모든 관련 오브젝트에 공통 라벨이 있는지 쉽게 확인할 수 있습니다.

후속 쿼리에서 해당 라벨을 사용할 수 있습니다. 예를 들어 애플리케이션 API 오브젝트를 전송할 수 있는 다음

oc명령 호출 세트를 고려하십시오.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 또는 이미 존재하는 경우

oc 프로젝트 <target_project>입니다.

참고oc export명령에서 이미지 스트림의 유형이 포함되는지 여부는파이프라인의 다양한 환경에서 이미지, 이미지 스트림 및 레지스트리를 관리하는 방법에 따라 다릅니다. 이 문제의 경고는 아래에서 설명합니다. 이미지 관리 주제도 참조하십시오.승격 파이프라인의 다양한 스테이징 환경에서 사용되는 각 레지스트리에 대해 작동하는 데 필요한 토큰도 가져와야 합니다. 각 환경에 대해 다음을 수행합니다.

환경에 로그인합니다.

oc login <each_environment_with_a_unique_registry>

$ oc login <each_environment_with_a_unique_registry>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음을 사용하여 액세스 토큰을 가져옵니다.

oc whoami -t

$ oc whoami -tCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 나중에 사용할 수 있도록 토큰 값을 복사하여 붙여넣습니다.

2.3.5.2. 반복 가능한 프로모션 프로세스

파이프라인에 대한 다양한 스테이징 환경을 설정한 후 반복 가능한 단계 세트를 통해 승격 파이프라인을 통해 애플리케이션의 각 반복을 검증할 수 있습니다. 소스 환경의 이미지 또는 API 오브젝트가 변경될 때마다 이러한 기본 단계가 수행됩니다.

업데이트된 이미지 이동 → 업데이트된 API 오브젝트 이동 → 환경별 사용자 정의 적용

일반적으로 첫 번째 단계는 애플리케이션과 관련된 이미지 업데이트를 파이프라인의 다음 단계로 승격하는 것입니다. 위에서 언급했듯이 이미지 승격의 주요 차이점은 OpenShift Container Platform 레지스트리가 스테이징 환경 간에 공유되는지 여부입니다.

레지스트리를 공유하는 경우

oc 태그를 활용합니다.oc tag <project_for_stage_N>/<imagestream_name_for_stage_N>:<tag_for_stage_N> <project_for_stage_N+1>/<imagestream_name_for_stage_N+1>:<tag_for_stage_N+1>

$ oc tag <project_for_stage_N>/<imagestream_name_for_stage_N>:<tag_for_stage_N> <project_for_stage_N+1>/<imagestream_name_for_stage_N+1>:<tag_for_stage_N+1>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 레지스트리가 공유되지 않는 경우 소스 및 대상 레지스트리에 로그인하여 애플리케이션 이미지를 적절하게 푸시할 때 승격된 각 파이프라인 레지스트리의 액세스 토큰을 활용할 수 있습니다.

소스 환경 레지스트리에 로그인합니다.

docker login -u <username> -e <any_email_address> -p <token_value> <src_env_registry_ip>:<port>

$ docker login -u <username> -e <any_email_address> -p <token_value> <src_env_registry_ip>:<port>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 애플리케이션의 이미지를 가져옵니다.

docker pull <src_env_registry_ip>:<port>/<namespace>/<image name>:<tag>

$ docker pull <src_env_registry_ip>:<port>/<namespace>/<image name>:<tag>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 애플리케이션 이미지를 대상 레지스트리의 위치에 태그하고, 대상 스테이징 환경을 준수하는 데 필요한 네임스페이스, 이름 및 태그를 업데이트합니다.

docker tag <src_env_registry_ip>:<port>/<namespace>/<image name>:<tag> <dest_env_registry_ip>:<port>/<namespace>/<image name>:<tag>

$ docker tag <src_env_registry_ip>:<port>/<namespace>/<image name>:<tag> <dest_env_registry_ip>:<port>/<namespace>/<image name>:<tag>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 대상 스테이징 환경 레지스트리에 로그인합니다.

docker login -u <username> -e <any_email_address> -p <token_value> <dest_env_registry_ip>:<port>

$ docker login -u <username> -e <any_email_address> -p <token_value> <dest_env_registry_ip>:<port>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이미지를 대상으로 푸시합니다.

docker push <dest_env_registry_ip>:<port>/<namespace>/<image name>:<tag>

$ docker push <dest_env_registry_ip>:<port>/<namespace>/<image name>:<tag>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 작은 정보외부 레지스트리에서 새 버전의 이미지를 자동으로 가져오려면

oc tag명령에--scheduled옵션이 있습니다. 사용하는 경우ImageStreamTag참조는 이미지를 호스팅하는 레지스트리에서 주기적으로 가져옵니다.

다음으로 애플리케이션 진화에서 API 오브젝트에 대한 기본 변경이나 애플리케이션을 구성하는 API 오브젝트 집합에서 추가 및 삭제 작업을 수행해야 하는 경우가 있습니다. 애플리케이션 API 오브젝트의 이러한 진화가 발생하면 OpenShift Container Platform CLI는 하나의 스테이징 환경에서 다음 단계로 변경할 수 있는 광범위한 옵션을 제공합니다.

프로모션 파이프라인을 처음 설정할 때와 동일한 방식으로 시작합니다.

oc login <source_environment> oc project <source_project> oc export dc,is,svc,route,secret,sa -l promotion-group=<application_name> -o yaml > export.yaml oc login <target_environment> oc <target_project>

$ oc login <source_environment> $ oc project <source_project> $ oc export dc,is,svc,route,secret,sa -l promotion-group=<application_name> -o yaml > export.yaml $ oc login <target_environment> $ oc <target_project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 단순히 새 환경에서 리소스를 생성하는 대신 업데이트합니다. 이 작업은 다음과 같은 몇 가지 방법으로 수행할 수 있습니다.

더 보수적인 접근 방식은

oc apply를 활용하고 대상 환경의 각 API 오브젝트에 새로운 변경 사항을 병합하는 것입니다. 이렇게 하면--dry-run=true옵션을 사용하고 실제로 오브젝트를 변경하기 전에 결과 오브젝트를 검사할 수 있습니다.oc apply -f export.yaml --dry-run=true

$ oc apply -f export.yaml --dry-run=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 충족되면 실제로

apply명령을 실행합니다.oc apply -f export.yaml

$ oc apply -f export.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow apply명령은 경우에 따라 더 복잡한 시나리오에 도움이 되는 추가 인수를 사용합니다. 자세한 내용은oc apply --help를 참조하십시오.또는 더 간단하고 공격적인 접근 방식은

oc replace를 활용하는 것입니다. 이 업데이트 및 교체와 함께 예행 연습이 없습니다. 가장 기본적인 형태로 다음을 실행합니다.oc replace -f export.yaml

$ oc replace -f export.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 적용되는것과 마찬가지로Replace는 보다 정교한 동작에 대한 추가 인수를 사용합니다. 자세한 내용은oc replace --help를 참조하십시오.

-

이전 단계에서는 도입된 새 API 오브젝트를 자동으로 처리하지만, 소스 환경에서 API 오브젝트가 삭제된 경우

oc delete를 사용하여 대상 환경에서 수동으로 삭제해야 합니다. API 오브젝트에 포함된 환경 변수 튜닝은 스테이징 환경마다 다를 수 있으므로 필요한 값이 필요할 수 있습니다. 이를 위해

oc set env를 사용하십시오.oc set env <api_object_type>/<api_object_ID> <env_var_name>=<env_var_value>

$ oc set env <api_object_type>/<api_object_ID> <env_var_name>=<env_var_value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

마지막으로

oc rollout명령 또는 위의 Deployments 섹션에서 설명하는 다른 메커니즘 중 하나를 사용하여 업데이트된 애플리케이션의 새 배포를 트리거합니다.

2.3.5.3. Jenkins를 사용하여 반복 가능한 승격 프로세스

OpenShift Container Platform의 Jenkins Docker 이미지에 정의된 OpenShift 샘플 작업은 Jenkins 구문에서 OpenShift Container Platform 내의 이미지 승격 예제입니다. 이 샘플의 설정은 OpenShift Origin 소스 리포지토리에 있습니다.

이 샘플에는 다음이 포함됩니다.

- Jenkins를 CI/CD 엔진으로 사용합니다.

-

Jenkins용 OpenShift Pipeline 플러그인을 사용합니다. 이 플러그인은 Jenkins Freestyle 및 DSL 작업 단계로 패키지된 OpenShift Container Platform용

ocCLI에서 제공하는 기능의 하위 집합을 제공합니다.oc바이너리는 OpenShift Container Platform의 Jenkins Docker 이미지에도 포함되며 Jenkins 작업의 OpenShift Container Platform과 상호 작용하는 데도 사용할 수 있습니다. - Jenkins에 대한 OpenShift Container Platform 제공 템플릿입니다. 임시 스토리지 및 영구 스토리지용 템플릿이 있습니다.

-

샘플 애플리케이션: OpenShift Origin 소스 리포지토리에 정의된 이 애플리케이션은

ImageStreams,ImageChangeTriggers,ImageStreamTags,BuildConfigs, 및 승격 파이프라인의 다른 단계에 해당하는 별도의DeploymentConfigs및Services를 활용합니다.

다음은 OpenShift 샘플 작업의 다양한 부분을 자세히 검사합니다.

-

첫 번째 단계는

oc scale dc frontend --replicas=0호출과 동일합니다. 이 단계는 실행 중일 수 있는 이전 버전의 애플리케이션 이미지를 중단하기 위한 것입니다. -

두 번째 단계는

oc start-build frontend호출과 동일합니다. -

세 번째 단계는

oc rollout latest dc/frontend호출과 동일합니다. - 네 번째 단계는 이 샘플의 '테스트'입니다. 이를 통해 이 애플리케이션의 연결된 서비스가 네트워크 관점에서 실제로 액세스할 수 있습니다. 커버에서 소켓 연결은 OpenShift Container Platform 서비스와 연결된 IP 주소 및 포트에 대해 시도됩니다. 물론 OpenShift Pipepline 플러그인 단계를 통해 추가 테스트를 추가한 다음 Jenkins Shell 단계를 통해 OS 수준 명령 및 스크립트를 활용하여 애플리케이션을 테스트할 수 있습니다.

-

다섯 번째 단계는 애플리케이션 테스트가 통과되어 이미지를 "사용 가능"으로 표시하려는 가정 하에 시작됩니다. 이 단계에서는 최신 이미지에서 애플리케이션 이미지에 대한 새 prod 태그가 생성됩니다. 해당 태그에 대해 frontend

DeploymentConfig에ImageChangeTrigger가 정의되어 있으면 해당 "production" 배포가 시작됩니다. - 마지막 단계는 플러그인에서 "프로덕션" 배포에 대해 원하는 수의 복제본 수를 시작했음을 확인하는 확인 단계입니다.

3장. 인증

3.1. 웹 콘솔 인증

< master_public_addr>:8443 의 브라우저에서 웹 콘솔에 액세스할 때 자동으로 로그인 페이지로 리디렉션됩니다.

웹 콘솔에 액세스하는 데 사용할 수 있는 브라우저 버전 및 운영 체제를 검토합니다.

이 페이지에서 로그인 자격 증명을 제공하여 API 호출을 위해 토큰을 가져올 수 있습니다. 로그인하면 웹 콘솔 을 사용하여 프로젝트를 탐색할 수 있습니다.

3.2. CLI 인증

CLI 명령 oc login 을 사용하여 명령줄에서 인증할 수 있습니다. 이 명령을 옵션 없이 실행하여 CLI를 시작할 수 있습니다.

oc login

$ oc login명령의 대화형 흐름은 제공된 인증 정보를 사용하여 OpenShift Container Platform 서버에 대한 세션을 설정하는 데 도움이 됩니다. OpenShift Container Platform 서버에 성공적으로 로그인하는 데 필요한 정보가 제공되지 않으면 명령은 필요에 따라 사용자 입력을 요청하는 메시지를 표시합니다. 이 구성은 자동으로 저장되며 이후의 모든 명령에 사용됩니다.

명령 출력에 나열된 oc login 명령의 모든 구성 옵션은 선택 사항입니다. 다음 예제에서는 몇 가지 일반적인 옵션과 함께 사용법을 보여줍니다.

oc login --help

oc login [-u=<username>] \ [-p=<password>] \ [-s=<server>] \ [-n=<project>] \ [--certificate-authority=</path/to/file.crt>|--insecure-skip-tls-verify]

$ oc login [-u=<username>] \

[-p=<password>] \

[-s=<server>] \

[-n=<project>] \

[--certificate-authority=</path/to/file.crt>|--insecure-skip-tls-verify]다음 표에서는 이러한 일반적인 옵션에 대해 설명합니다.

| 옵션 | 구문 | 설명 |

|---|---|---|

|

|

oc login -s=<server> | OpenShift Container Platform 서버의 호스트 이름을 지정합니다. 이 플래그를 통해 서버를 제공하면 명령에서 대화형으로 요청하지 않습니다. 이 플래그는 CLI 구성 파일이 이미 있고 다른 서버에 로그인하고 전환하려는 경우에도 사용할 수 있습니다. |

|

|

oc login -u=<username> -p=<password> | OpenShift Container Platform 서버에 로그인할 인증 정보를 지정할 수 있습니다. 이러한 플래그를 통해 사용자 이름 또는 암호를 제공하면 명령에서 대화형으로 요청하지 않습니다. 이러한 플래그는 세션 토큰이 설정된 구성 파일이 이미 있고 로그인하고 다른 사용자 이름으로 전환하려는 경우에도 사용할 수 있습니다. |

|

|

oc login -u=<username> -p=<password> -n=<project> |

|

|

|

oc login --certificate-authority=<path/to/file.crt> | HTTPS를 사용하는 OpenShift Container Platform 서버를 사용하여 정확하고 안전하게 인증합니다. 인증 기관 파일의 경로를 제공해야 합니다. |

|

|

oc login --insecure-skip-tls-verify |

서버 인증서 확인을 바이패스하는 HTTPS 서버와의 상호 작용을 허용하지만 안전하지는 않습니다. 유효한 인증서를 제공하지 않는 HTTPS 서버에 |

CLI 구성 파일을 사용하면 여러 CLI 프로필을 쉽게 관리할 수 있습니다.

관리자 자격 증명에 대한 액세스 권한이 있지만 기본 시스템 사용자 system:admin 으로 더 이상 로그인하지 않은 경우 CLI 구성 파일에 인증 정보가 계속 있는 한 언제든지 이 사용자로 다시 로그인할 수 있습니다. 다음 명령은 로그인하고 기본 프로젝트로 전환합니다.

oc login -u system:admin -n default

$ oc login -u system:admin -n default4장. 권한 부여

4.1. 개요

이 주제에는 클러스터 관리자가 지정한 대로 애플리케이션 개발자와 해당 기능에 대한 권한 부여 작업이 포함되어 있습니다.

4.2. 사용자가 Pod를 만들 수 있는지 확인

scc-review 및 scc-subject-review 옵션을 사용하면 개별 사용자 또는 특정 서비스 계정의 사용자가 포드를 생성하거나 업데이트할 수 있는지 확인할 수 있습니다.

scc-review 옵션을 사용하여 서비스 계정에서 Pod를 생성하거나 업데이트할 수 있는지 확인할 수 있습니다. 이 명령은 리소스를 허용하는 보안 컨텍스트 제약 조건을 출력합니다.

예를 들어 system:serviceaccount:projectname:default 서비스 계정이 있는 사용자가 Pod를 생성할 수 있는지 확인하려면 다음을 실행합니다.

oc policy scc-review -z system:serviceaccount:projectname:default -f my_resource.yaml

$ oc policy scc-review -z system:serviceaccount:projectname:default -f my_resource.yaml

scc-subject-review 옵션을 사용하여 특정 사용자가 Pod를 생성하거나 업데이트할 수 있는지 확인할 수도 있습니다.

oc policy scc-subject-review -u <username> -f my_resource.yaml

$ oc policy scc-subject-review -u <username> -f my_resource.yaml특정 그룹에 속하는 사용자가 특정 파일에 Pod를 생성할 수 있는지 확인하려면 다음을 수행하십시오.

oc policy scc-subject-review -u <username> -g <groupname> -f my_resource.yaml

$ oc policy scc-subject-review -u <username> -g <groupname> -f my_resource.yaml4.3. 인증된 사용자로 수행할 수 있는 작업 확인

OpenShift Container Platform 프로젝트 내에서 모든 네임스페이스 범위 리소스(타사 리소스 포함)에 대해 수행할 수 있는 동사 를 확인할 수 있습니다.

can-i 명령 옵션은 사용자 및 역할 측면에서 범위를 테스트합니다.

oc policy can-i --list --loglevel=8

$ oc policy can-i --list --loglevel=8출력에서는 정보를 수집할 API 요청을 결정하는 데 도움이 됩니다.

정보를 사용자가 읽을 수 있는 형식으로 다시 수신하려면 다음을 실행합니다.

oc policy can-i --list

$ oc policy can-i --list출력에 전체 목록이 제공됩니다.

특정 동사를 수행할 수 있는지 확인하려면 다음을 실행합니다.

oc policy can-i <verb> <resource>

$ oc policy can-i <verb> <resource>사용자 범위는 지정된 범위에 대한 자세한 정보를 제공할 수 있습니다. 예를 들어 다음과 같습니다.

oc policy can-i <verb> <resource> --scopes=user:info

$ oc policy can-i <verb> <resource> --scopes=user:info5장. 프로젝트

5.1. 개요

사용자 커뮤니티는 프로젝트를 통해 다른 커뮤니티와 별도로 콘텐츠를 구성하고 관리할 수 있습니다.

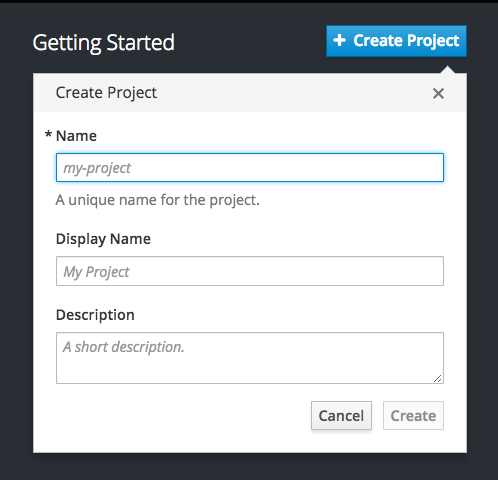

5.2. 프로젝트 생성

클러스터 관리자가 허용하는 경우 CLI 또는 웹 콘솔 을 사용하여 새 프로젝트를 생성할 수 있습니다.

5.2.1. 웹 콘솔 사용

웹 콘솔을 사용하여 새 프로젝트를 생성하려면 프로젝트 패널 또는 프로젝트 페이지에서 Create Project (프로젝트 만들기) 버튼을 클릭합니다.

Create Project (프로젝트 만들기) 버튼이 기본적으로 표시되지만 선택적으로 숨겨지거나 사용자 지정할 수 있습니다.

5.2.2. CLI 사용

CLI를 사용하여 새 프로젝트를 생성하려면 다음을 수행합니다.

oc new-project <project_name> \

--description="<description>" --display-name="<display_name>"

$ oc new-project <project_name> \

--description="<description>" --display-name="<display_name>"예를 들어 다음과 같습니다.

oc new-project hello-openshift \

--description="This is an example project to demonstrate OpenShift v3" \

--display-name="Hello OpenShift"

$ oc new-project hello-openshift \

--description="This is an example project to demonstrate OpenShift v3" \

--display-name="Hello OpenShift"작성할 수 있는 프로젝트 수는 시스템 관리자가 제한할 수 있습니다. 한도에 도달하면 새 프로젝트를 생성하려면 기존 프로젝트를 삭제해야 할 수 있습니다.

5.3. 프로젝트 보기

프로젝트를 볼 때 권한 부여 정책에 따라 볼 수 있는 액세스 권한이 있는 프로젝트만 볼 수 있습니다.

프로젝트 목록을 보려면 다음을 수행합니다.

oc get projects

$ oc get projectsCLI 작업을 위해 현재 프로젝트에서 다른 프로젝트로 변경할 수 있습니다. 그러면 지정된 프로젝트가 프로젝트 범위의 콘텐츠를 조작하는 모든 후속 작업에서 사용됩니다.

oc project <project_name>

$ oc project <project_name>웹 콘솔 을 사용하여 프로젝트 간에 보고 변경할 수도 있습니다. 인증 및 로그인 후 액세스 권한이 있는 프로젝트 목록이 표시됩니다.

서비스 카탈로그와 함께 표시된 오른쪽 패널은 가장 최근에 액세스한 프로젝트(최대 5개의 프로젝트)에 빠르게 액세스할 수 있습니다. 전체 프로젝트 목록은 오른쪽 패널 상단에 있는 View All (모두 보기) 링크를 사용합니다.

CLI를 사용하여 새 프로젝트를 생성하는 경우 브라우저에서 페이지를 새로 고침하여 새 프로젝트를 확인할 수 있습니다.

프로젝트를 선택하면 해당 프로젝트의 프로젝트 개요 로 이동합니다.

특정 프로젝트의 kebab 메뉴를 클릭하면 다음 옵션이 표시됩니다.

5.4. 프로젝트 상태 확인

oc status 명령은 현재 프로젝트에 대한 고급 개요와 해당 구성 요소 및 해당 관계를 제공합니다. 이 명령은 인수를 사용하지 않습니다.

oc status

$ oc status5.5. 라벨로 필터링

리소스 레이블 을 사용하여 웹 콘솔 의 프로젝트 페이지 콘텐츠를 필터링할 수 있습니다. 제안된 라벨 이름과 값 중에서 선택하거나 자체적으로 를 입력할 수 있습니다. 여러 필터를 추가할 수 있습니다. 여러 필터를 적용하면 리소스가 모든 필터와 일치하여 표시됨을 유지해야 합니다.

라벨을 기준으로 필터링하려면 다음을 수행합니다.

라벨 유형을 선택합니다.

다음 명령 중 하나를 선택합니다.

Exists

레이블 이름이 있지만 해당 값을 무시합니다.

존재하지 않음

레이블 이름이 없지만 해당 값을 무시합니다.

in

레이블 이름이 존재하고 선택한 값 중 하나와 같은지 확인합니다.

들어 있지 않음

레이블 이름이 없거나 선택한 값과 같지 않은지 확인합니다.

에서 선택한 경우 값 집합을 선택한 다음 필터 를 선택합니다.

필터를 추가한 후 모든 필터 지우기를 선택하거나 개별 필터를 클릭하여 필터 를 제거하여 필터링을 중지할 수 있습니다.

5.6. 페이지 번호 표시

OpenShift Container Platform 웹 콘솔 은 이제 레이블 필터 및 기타 설정을 저장하는 데 도움이 되는 북마크 페이지 상태가 표시됩니다.

탭 간 전환과 같이 페이지 상태를 변경하려면 브라우저의 탐색 모음의 URL이 자동으로 업데이트됩니다.

5.7. 프로젝트 삭제

프로젝트를 삭제하면 서버에서 프로젝트 상태를 활성에서 종료로 업데이트합니다. 그런 다음 서버는 프로젝트를 마지막으로 제거하기 전에 종료 중인 프로젝트에서 모든 콘텐츠를 지웁니다. 프로젝트가 종료 상태인 동안 사용자는 프로젝트에 새 콘텐츠를 추가할 수 없습니다. CLI 또는 웹 콘솔에서 프로젝트를 삭제할 수 있습니다.

CLI를 사용하여 프로젝트를 삭제하려면 다음을 수행합니다.

oc delete project <project_name>

$ oc delete project <project_name>6장. 애플리케이션 마이그레이션

6.1. 개요

이 주제에서는 OpenShift 버전 3(v3)으로 OpenShift 버전 2(v2) 애플리케이션의 마이그레이션 프로세스에 대해 설명합니다.

이 주제에서는 OpenShift v2와 관련된 일부 용어를 사용합니다. OpenShift Enterprise 2와 OpenShift Enterprise 3을 비교하면 두 버전과 사용된 언어의 차이점에 대한 통찰력을 얻을 수 있습니다.

OpenShift v2 애플리케이션을 OpenShift Container Platform v3으로 마이그레이션하려면 v2 애플리케이션의 모든 카트리지를 각각 OpenShift Container Platform v3의 해당 이미지 또는 템플릿과 동일하므로 기록해야 하며 개별적으로 마이그레이션해야 합니다. 각 MongoDB마다 모든 종속 항목 또는 필수 패키지도 v3 이미지에 포함되어야 하므로 기록해야 합니다.

일반적인 마이그레이션 절차는 다음과 같습니다.

v2 애플리케이션을 백업합니다.

- 웹 카트리지: GitHub의 리포지토리로 내보내와 같은 Git 리포지토리로 소스 코드를 백업할 수 있습니다.

-

데이터베이스 카트리지: 덤프 명령(

mongodump,mysqldump,pg_dump)을 사용하여 데이터베이스를 백업할 수 있습니다. 웹 및 데이터베이스 카트리지:

rhc클라이언트 툴은 여러 개의 Fluentd를 백업할 수 있는 스냅샷 기능을 제공합니다.rhc snapshot save <app_name>

$ rhc snapshot save <app_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 스냅샷은 압축을 풀 수 있는 tar 파일이며 해당 내용은 애플리케이션 소스 코드와 데이터베이스 덤프입니다.

- 애플리케이션에 데이터베이스 카트리지가 있는 경우 v3 데이터베이스 애플리케이션을 생성하고 데이터베이스 덤프를 새 v3 데이터베이스 애플리케이션의 Pod로 동기화한 다음, 데이터베이스 복원 명령을 사용하여 v3 데이터베이스 애플리케이션의 v2 데이터베이스 데이터베이스를 복원합니다.

- 웹 프레임워크 애플리케이션의 경우 애플리케이션 소스 코드를 편집하여 v3와 호환되도록 합니다. 그런 다음 Git 리포지토리의 적절한 파일에 필요한 종속성 또는 패키지를 추가합니다. v2 환경 변수를 해당 v3 환경 변수로 변환합니다.

- 소스(Git 리포지토리) 또는 Git URL을 사용한 빠른 시작에서 v3 애플리케이션을 생성합니다. 또한 데이터베이스 서비스 매개 변수를 새 애플리케이션에 추가하여 데이터베이스 애플리케이션을 웹 애플리케이션에 연결합니다.

- v2에는 통합 Git 환경이 있으며, 변경 사항이 v2 Git 리포지토리로 푸시될 때마다 애플리케이션이 자동으로 다시 빌드 및 재시작됩니다. v3에서 소스 코드 변경으로 인해 빌드가 자동으로 트리거되도록 하려면 v3의 초기 빌드가 완료된 후 Webhook 를 설정해야 합니다.

6.2. 데이터베이스 애플리케이션 마이그레이션

6.2.1. 개요

이 주제에서는 OpenShift 버전 2(v2)에서 OpenShift 버전 3(v3)으로 MySQL, PostgreSQL 및 MongoDB 데이터베이스 애플리케이션을 마이그레이션하는 방법을 검토합니다.

6.2.2. 지원되는 데이터베이스

| v2 | v3 |

|---|---|

| MongoDB: 2.4 | MongoDB: 2.4, 2.6 |

| MySQL: 5.5 | MySQL: 5.5, 5.6 |

| PostgreSQL: 9.2 | PostgreSQL: 9.2, 9.4 |

6.2.3. MySQL

모든 데이터베이스를 덤프 파일로 내보내고 로컬 머신 (현재 디렉토리에 있음)에 복사합니다.

rhc ssh <v2_application_name> mysqldump --skip-lock-tables -h $OPENSHIFT_MYSQL_DB_HOST -P ${OPENSHIFT_MYSQL_DB_PORT:-3306} -u ${OPENSHIFT_MYSQL_DB_USERNAME:-'admin'} \ --password="$OPENSHIFT_MYSQL_DB_PASSWORD" --all-databases > ~/app-root/data/all.sql exit$ rhc ssh <v2_application_name> $ mysqldump --skip-lock-tables -h $OPENSHIFT_MYSQL_DB_HOST -P ${OPENSHIFT_MYSQL_DB_PORT:-3306} -u ${OPENSHIFT_MYSQL_DB_USERNAME:-'admin'} \ --password="$OPENSHIFT_MYSQL_DB_PASSWORD" --all-databases > ~/app-root/data/all.sql $ exitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 로컬 머신에 dbdump 를 다운로드합니다.

mkdir mysqldumpdir rhc scp -a <v2_application_name> download mysqldumpdir app-root/data/all.sql

$ mkdir mysqldumpdir $ rhc scp -a <v2_application_name> download mysqldumpdir app-root/data/all.sqlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 템플릿에서 v3 mysql-persistent Pod를 생성합니다.

oc new-app mysql-persistent -p \ MYSQL_USER=<your_V2_mysql_username> -p \ MYSQL_PASSWORD=<your_v2_mysql_password> -p MYSQL_DATABASE=<your_v2_database_name>

$ oc new-app mysql-persistent -p \ MYSQL_USER=<your_V2_mysql_username> -p \ MYSQL_PASSWORD=<your_v2_mysql_password> -p MYSQL_DATABASE=<your_v2_database_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Pod를 사용할 준비가 되었는지 확인합니다.

oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod가 실행 중이면 데이터베이스 아카이브 파일을 v3 MySQL Pod에 복사합니다.

oc rsync /local/mysqldumpdir <mysql_pod_name>:/var/lib/mysql/data

$ oc rsync /local/mysqldumpdir <mysql_pod_name>:/var/lib/mysql/dataCopy to Clipboard Copied! Toggle word wrap Toggle overflow v3 실행 Pod에서 데이터베이스를 복원합니다.

oc rsh <mysql_pod> cd /var/lib/mysql/data/mysqldumpdir

$ oc rsh <mysql_pod> $ cd /var/lib/mysql/data/mysqldumpdirCopy to Clipboard Copied! Toggle word wrap Toggle overflow v3에서 데이터베이스를 복원하려면 root 사용자로 MySQL에 액세스해야 합니다.

v2에서

$OPENSHIFT_MYSQL_DB_USERNAME에는 모든 데이터베이스에 대한 전체 권한이 있습니다. v3에서는 각 데이터베이스에 대해$MYSQL_USER에 권한을 부여해야 합니다.mysql -u root source all.sql

$ mysql -u root $ source all.sqlCopy to Clipboard Copied! Toggle word wrap Toggle overflow < dbname >에 모든 권한을 <

your_v2_username>@localhost에 부여한 다음 권한을 플러시합니다.Pod에서 덤프 디렉터리를 제거합니다.

cd ../; rm -rf /var/lib/mysql/data/mysqldumpdir

$ cd ../; rm -rf /var/lib/mysql/data/mysqldumpdirCopy to Clipboard Copied! Toggle word wrap Toggle overflow

지원되는 MySQL 환경 변수

| v2 | v3 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| |

|

| |

|

| |

|

| |

|

| |

|

|

6.2.4. PostgreSQL

장치에서 v2 PostgreSQL 데이터베이스를 백업합니다.

rhc ssh -a <v2-application_name> mkdir ~/app-root/data/tmp pg_dump <database_name> | gzip > ~/app-root/data/tmp/<database_name>.gz

$ rhc ssh -a <v2-application_name> $ mkdir ~/app-root/data/tmp $ pg_dump <database_name> | gzip > ~/app-root/data/tmp/<database_name>.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow 백업 파일을 로컬 머신에 다시 추출합니다.

rhc scp -a <v2_application_name> download <local_dest> app-root/data/tmp/<db-name>.gz gzip -d <database-name>.gz

$ rhc scp -a <v2_application_name> download <local_dest> app-root/data/tmp/<db-name>.gz $ gzip -d <database-name>.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고4단계에 대해 백업 파일을 별도의 폴더에 저장합니다.

새 서비스를 생성하기 위해 v2 애플리케이션 데이터베이스 이름, 사용자 이름 및 암호를 사용하여 PostgreSQL 서비스를 생성합니다.

oc new-app postgresql-persistent -p POSTGRESQL_DATABASE=dbname -p POSTGRESQL_PASSWORD=password -p POSTGRESQL_USER=username

$ oc new-app postgresql-persistent -p POSTGRESQL_DATABASE=dbname -p POSTGRESQL_PASSWORD=password -p POSTGRESQL_USER=usernameCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod를 사용할 준비가 되었는지 확인합니다.

oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod가 실행 중인 경우 백업 디렉터리를 Pod에 동기화합니다.

oc rsync /local/path/to/dir <postgresql_pod_name>:/var/lib/pgsql/data

$ oc rsync /local/path/to/dir <postgresql_pod_name>:/var/lib/pgsql/dataCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod에 원격으로 액세스합니다.

oc rsh <pod_name>

$ oc rsh <pod_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 데이터베이스를 복원합니다.

psql dbname < /var/lib/pgsql/data/<database_backup_file>

psql dbname < /var/lib/pgsql/data/<database_backup_file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 더 이상 필요하지 않은 모든 백업 파일을 제거하십시오.

rm /var/lib/pgsql/data/<database-backup-file>

$ rm /var/lib/pgsql/data/<database-backup-file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

지원되는 PostgreSQL 환경 변수

| v2 | v3 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

|

6.2.5. MongoDB

- OpenShift v3의 경우: MongoDB 쉘 버전 3.2.6

- OpenShift v2: MongoDB 쉘 버전 2.4.9의 경우

ssh명령을 통해 v2 애플리케이션에 원격으로 액세스합니다.rhc ssh <v2_application_name>

$ rhc ssh <v2_application_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow mongodump 를 실행하여

-d <database_name> -c <collections>로 단일 데이터베이스를 지정합니다. 이러한 옵션이 없으면 모든 데이터베이스를 덤프합니다. 각 데이터베이스는 자체 디렉터리에 덤프됩니다.mongodump -h $OPENSHIFT_MONGODB_DB_HOST -o app-root/repo/mydbdump -u 'admin' -p $OPENSHIFT_MONGODB_DB_PASSWORD cd app-root/repo/mydbdump/<database_name>; tar -cvzf dbname.tar.gz exit

$ mongodump -h $OPENSHIFT_MONGODB_DB_HOST -o app-root/repo/mydbdump -u 'admin' -p $OPENSHIFT_MONGODB_DB_PASSWORD $ cd app-root/repo/mydbdump/<database_name>; tar -cvzf dbname.tar.gz $ exitCopy to Clipboard Copied! Toggle word wrap Toggle overflow mongodump 디렉터리의 로컬 머신에 dbdump 를 다운로드합니다.

mkdir mongodump rhc scp -a <v2 appname> download mongodump \ app-root/repo/mydbdump/<dbname>/dbname.tar.gz

$ mkdir mongodump $ rhc scp -a <v2 appname> download mongodump \ app-root/repo/mydbdump/<dbname>/dbname.tar.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow v3에서 MongoDB 포드를 시작합니다. 최신 이미지(3.2.6)에는 mongo-tools 가 포함되지 않으므로

mongorestore또는mongoimport명령을 사용하려면 기본 mongodb-persistent 템플릿을 편집하여mongo-tools, "mongodb:2.4"가 포함된 이미지 태그를 지정해야 합니다. 따라서 다음oc export명령 및 편집이 필요합니다.oc export template mongodb-persistent -n openshift -o json > mongodb-24persistent.json

$ oc export template mongodb-persistent -n openshift -o json > mongodb-24persistent.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow L80 of mongodb-24persistent.json 을 편집하고

mongodb:latest를mongodb:2.4로 바꿉니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow mongodb pod가 실행 중이면 데이터베이스 아카이브 파일을 v3 MongoDB Pod에 복사합니다.

oc rsync local/path/to/mongodump <mongodb_pod_name>:/var/lib/mongodb/data oc rsh <mongodb_pod>

$ oc rsync local/path/to/mongodump <mongodb_pod_name>:/var/lib/mongodb/data $ oc rsh <mongodb_pod>Copy to Clipboard Copied! Toggle word wrap Toggle overflow MongoDB 포드에서 복원할 각 데이터베이스에 대해 다음을 완료합니다.

cd /var/lib/mongodb/data/mongodump tar -xzvf dbname.tar.gz mongorestore -u $MONGODB_USER -p $MONGODB_PASSWORD -d dbname -v /var/lib/mongodb/data/mongodump

$ cd /var/lib/mongodb/data/mongodump $ tar -xzvf dbname.tar.gz $ mongorestore -u $MONGODB_USER -p $MONGODB_PASSWORD -d dbname -v /var/lib/mongodb/data/mongodumpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 데이터베이스가 복원되었는지 확인합니다.

mongo admin -u $MONGODB_USER -p $MONGODB_ADMIN_PASSWORD use dbname show collections exit

$ mongo admin -u $MONGODB_USER -p $MONGODB_ADMIN_PASSWORD $ use dbname $ show collections $ exitCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod에서 mongodump 디렉터리를 제거합니다.

rm -rf /var/lib/mongodb/data/mongodump

$ rm -rf /var/lib/mongodb/data/mongodumpCopy to Clipboard Copied! Toggle word wrap Toggle overflow

지원되는 MongoDB 환경 변수

| v2 | v3 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

|

6.3. 웹 프레임워크 애플리케이션 마이그레이션

6.3.1. 개요

이 주제에서는 Python, Ruby, PHP, Perl, Node.js, WordPress, Ghost, JBoss EAP, JBoss WS(Tomcat) 및 Wildfly 10(JBoss AS) 웹 프레임워크 애플리케이션을 OpenShift 버전 2(v2)에서 OpenShift 버전 3(v3)으로 마이그레이션하는 방법을 검토합니다.

6.3.2. Python

새 GitHub 리포지토리를 설정하고 현재 로컬 v2 Git 리포지토리에 원격 분기로 추가합니다.

git remote add <remote-name> https://github.com/<github-id>/<repo-name>.git

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>.gitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 로컬 v2 소스 코드를 새 리포지토리로 내보냅니다.

git push -u <remote-name> master

$ git push -u <remote-name> masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow setup.py, wsgi.py, requirements.txt 등과 같은 중요한 파일이 모두 새 리포지토리로 푸시되었는지 확인합니다.

- 애플리케이션에 필요한 모든 패키지가 requirements.txt 에 포함되어 있는지 확인합니다.

oc명령을 사용하여 빌더 이미지 및 소스 코드에서 새 Python 애플리케이션을 시작합니다.oc new-app --strategy=source python:3.3~https://github.com/<github-id>/<repo-name> --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>

$ oc new-app --strategy=source python:3.3~https://github.com/<github-id>/<repo-name> --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

지원되는 Python 버전

| v2 | v3 |

|---|---|

| Python: 2.6, 2.7, 3.3 | |

| Django | Django-psql-example (quickstart) |

6.3.3. Ruby

새 GitHub 리포지토리를 설정하고 현재 로컬 v2 Git 리포지토리에 원격 분기로 추가합니다.

git remote add <remote-name> https://github.com/<github-id>/<repo-name>.git

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>.gitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 로컬 v2 소스 코드를 새 리포지토리로 내보냅니다.

git push -u <remote-name> master

$ git push -u <remote-name> masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow Gemfile이 없고 간단한 랙 애플리케이션을 실행 중인 경우 이 Gemfile을 소스의 루트에 복사합니다.

https://github.com/sclorg/ruby-ex/blob/master/Gemfile

https://github.com/sclorg/ruby-ex/blob/master/GemfileCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고Ruby 2.0을 지원하는 랙 gem의 최신 버전은 1.6.4이므로 Gemfile은

gem 'rack', "1.6.4"로 수정되어야 합니다.Ruby 2.2 이상의 경우 rack gem 2.0 이상을 사용하십시오.

oc명령을 사용하여 빌더 이미지 및 소스 코드에서 새 Ruby 애플리케이션을 시작합니다.oc new-app --strategy=source ruby:2.0~https://github.com/<github-id>/<repo-name>.git

$ oc new-app --strategy=source ruby:2.0~https://github.com/<github-id>/<repo-name>.gitCopy to Clipboard Copied! Toggle word wrap Toggle overflow

지원되는 Ruby 버전

| v2 | v3 |

|---|---|

| Ruby: 1.8, 1.9, 2.0 | |

| Ruby on Rails: 3, 4 | Rails-postgresql-example(quickstart) |

| Sinatra |

6.3.4. PHP

새 GitHub 리포지토리를 설정하고 현재 로컬 v2 Git 리포지토리에 원격 분기로 추가합니다.

git remote add <remote-name> https://github.com/<github-id>/<repo-name>

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 로컬 v2 소스 코드를 새 리포지토리로 내보냅니다.

git push -u <remote-name> master

$ git push -u <remote-name> masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc명령을 사용하여 빌더 이미지 및 소스 코드에서 새 PHP 애플리케이션을 시작합니다.oc new-app https://github.com/<github-id>/<repo-name>.git --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>

$ oc new-app https://github.com/<github-id>/<repo-name>.git --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

지원되는 PHP 버전

| v2 | v3 |

|---|---|

| PHP: 5.3, 5.4 | |

| PHP 5.4 with Zend Server 6.1 | |

| CodeIgniter 2 | |

| HHVM | |

| Laravel 5.0 | |

| CakePHP-mysql-example (quickstart) |

6.3.5. Perl

새 GitHub 리포지토리를 설정하고 현재 로컬 v2 Git 리포지토리에 원격 분기로 추가합니다.

git remote add <remote-name> https://github.com/<github-id>/<repo-name>

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 로컬 v2 소스 코드를 새 리포지토리로 내보냅니다.

git push -u <remote-name> master

$ git push -u <remote-name> masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 로컬 Git 리포지토리를 편집하고 업스트림에 변경 사항을 푸시하여 v3와 호환되도록 합니다.

v2, CPAN 모듈은 .openshift/cpan.txt 에 있습니다. v3에서 s2i 빌더는 소스의 루트 디렉터리에서 cpanfile 이라는 파일을 찾습니다.

cd <local-git-repository> mv .openshift/cpan.txt cpanfile

$ cd <local-git-repository> $ mv .openshift/cpan.txt cpanfileCopy to Clipboard Copied! Toggle word wrap Toggle overflow cpanfile은 약간 다른 형식이 있습니다.

Expand cpanfile 형식 cpan.txt 형식 requires ‘cpan::mod’;

cpan::mod

'Dancer'가 필요합니다.

댄서

'YAML'이 필요합니다.

YAML

.openshift 디렉터리 제거

참고v3에서는 action_hooks 및 cron 작업이 동일한 방식으로 지원되지 않습니다. 자세한 내용은 동작 후크 를 참조하십시오.

-

oc명령을 사용하여 빌더 이미지 및 소스 코드에서 새 Perl 애플리케이션을 시작합니다.

oc new-app https://github.com/<github-id>/<repo-name>.git

$ oc new-app https://github.com/<github-id>/<repo-name>.git지원되는 Perl 버전

| v2 | v3 |

|---|---|

| Perl: 5.10 | |

| Danr-mysql-example (quickstart) |

6.3.6. Node.js

새 GitHub 리포지토리를 설정하고 이를 현재 로컬 Git 리포지토리에 원격 분기로 추가합니다.

git remote add <remote-name> https://github.com/<github-id>/<repo-name>

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 로컬 v2 소스 코드를 새 리포지토리로 내보냅니다.

git push -u <remote-name> master

$ git push -u <remote-name> masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 로컬 Git 리포지토리를 편집하고 업스트림에 변경 사항을 푸시하여 v3와 호환되도록 합니다.

.openshift 디렉터리를 제거합니다.

참고v3에서는 action_hooks 및 cron 작업이 동일한 방식으로 지원되지 않습니다. 자세한 내용은 동작 후크 를 참조하십시오.

server.js 를 편집합니다.

- L116 server.js: 'self.app = express();'

- L25 server.js: self.ipaddress = '0.0.0.0';

L26 server.js: self.port = 8080;

참고line(L)은 기본 V2 카트리지 server.js.js에서 가져온 것입니다.

oc명령을 사용하여 빌더 이미지 및 소스 코드에서 새 Node.js 애플리케이션을 시작합니다.oc new-app https://github.com/<github-id>/<repo-name>.git --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>

$ oc new-app https://github.com/<github-id>/<repo-name>.git --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

지원되는 Node.js 버전

| v2 | v3 |

|---|---|

| Node.js 0.10 | |

| nodejs-mongodb-example. 이 빠른 시작 템플릿은 Node.js 버전 6만 지원합니다. |

6.3.7. WordPress

현재 WordPress 애플리케이션 마이그레이션 지원은 Red Hat이 지원하지 않고 커뮤니티에서 제공합니다.

WordPress 애플리케이션을 OpenShift Container Platform v3으로 마이그레이션하는 방법에 대한 지침은 OpenShift 블로그를 참조하십시오.

6.3.8. 유령

현재 Ghost 애플리케이션 마이그레이션 지원은 Red Hat이 지원하지 않고 커뮤니티에서 제공합니다.

Ghost 애플리케이션을 OpenShift Container Platform v3으로 마이그레이션하는 방법에 대한 지침은 OpenShift 블로그를 참조하십시오.

6.3.9. JBoss EAP

새 GitHub 리포지토리를 설정하고 이를 현재 로컬 Git 리포지토리에 원격 분기로 추가합니다.

git remote add <remote-name> https://github.com/<github-id>/<repo-name>

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 로컬 v2 소스 코드를 새 리포지토리로 내보냅니다.

git push -u <remote-name> master

$ git push -u <remote-name> masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 리포지토리에 사전 빌드된 .war 파일이 포함된 경우 리포지토리의 루트 디렉터리의 배포 디렉터리에 있어야 합니다.

JBoss EAP 7 빌더 이미지(jboss-eap70-openshift) 및 GitHub의 소스 코드 리포지터리를 사용하여 새 애플리케이션을 생성합니다.

oc new-app --strategy=source jboss-eap70-openshift:1.6~https://github.com/<github-id>/<repo-name>.git

$ oc new-app --strategy=source jboss-eap70-openshift:1.6~https://github.com/<github-id>/<repo-name>.gitCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.3.10. JBoss WS(Tomcat)

새 GitHub 리포지토리를 설정하고 이를 현재 로컬 Git 리포지토리에 원격 분기로 추가합니다.

git remote add <remote-name> https://github.com/<github-id>/<repo-name>

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 로컬 v2 소스 코드를 새 리포지토리로 내보냅니다.

git push -u <remote-name> master

$ git push -u <remote-name> masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 리포지토리에 사전 빌드된 .war 파일이 포함된 경우 리포지토리의 루트 디렉터리의 배포 디렉터리에 있어야 합니다.

JBoss Web Server 3(Tomcat 7) 빌더 이미지(jboss-webserver30-tomcat7) 및 GitHub의 소스 코드 리포지터리를 사용하여 새 애플리케이션을 생성합니다.

oc new-app --strategy=source jboss-webserver30-tomcat7-openshift~https://github.com/<github-id>/<repo-name>.git --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>

$ oc new-app --strategy=source jboss-webserver30-tomcat7-openshift~https://github.com/<github-id>/<repo-name>.git --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.3.11. JBoss AS(Wildfly 10)

새 GitHub 리포지토리를 설정하고 이를 현재 로컬 Git 리포지토리에 원격 분기로 추가합니다.

git remote add <remote-name> https://github.com/<github-id>/<repo-name>

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 로컬 v2 소스 코드를 새 리포지토리로 내보냅니다.

git push -u <remote-name> master

$ git push -u <remote-name> masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 로컬 Git 리포지토리를 편집하고 업스트림 변경 사항을 푸시하여 v3와 호환되도록 합니다.

.openshift 디렉터리를 제거합니다.

참고v3에서는 action_hooks 및 cron 작업이 동일한 방식으로 지원되지 않습니다. 자세한 내용은 동작 후크 를 참조하십시오.

- 배포 디렉터리를 소스 리포지토리의 루트에 추가합니다. .war 파일을 'deployments' 디렉터리로 이동합니다.

oc명령을 사용하여 빌더 이미지 및 소스 코드에서 새 Wildfly 애플리케이션을 시작합니다.oc new-app https://github.com/<github-id>/<repo-name>.git --image-stream=”openshift/wildfly:10.0" --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>

$ oc new-app https://github.com/<github-id>/<repo-name>.git --image-stream=”openshift/wildfly:10.0" --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고인수

--name은 애플리케이션 이름을 지정하는 선택적입니다.-e인수는OPENSHIFT_PYTHON_DIR과 같은 빌드 및 배포 프로세스에 필요한 환경 변수를 추가하기 위한 옵션입니다.

6.3.12. 지원되는 JBoss 버전

| v2 | v3 |

|---|---|

| JBoss App Server 7 | |

| Tomcat 6 (JBoss EWS 1.0) | |

| Tomcat 7 (JBoss EWS 2.0) | |

| Vert.x 2.1 | |

| WildFly App Server 10 | |

| WildFly App Server 8.2.1.Final | |

| WildFly App Server 9 | |

| CapeDwarf | |

| JBoss Data Virtualization 6 | |

| JBoss EAP(Enterprise App Platform) 6 | |

| JBoss Unified Push Server 1.0.0.Beta1, Beta2 | |

| JBoss BPM 제품군 | |

| JBoss BRMS | |

| jboss-eap70-openshift: 1.3-Beta | |

| eap64-https-s2i | |

| eap64-mongodb-persistent-s2i | |

| eap64-mysql-persistent-s2i | |

| eap64-psql-persistent-s2i |

6.4. 빠른 시작 예

6.4.1. 개요

v2 빠른 시작에서 v3 빠른 시작에 대한 명확한 마이그레이션 경로는 없지만 현재 다음 빠른 시작 서비스는 v3에서 사용할 수 있습니다. oc new-app 을 사용하여 애플리케이션을 생성하는 대신 데이터베이스가 있는 경우 oc new-app 을 다시 시작하여 별도의 데이터베이스 서비스를 시작하고 공통 환경 변수가 있는 두 개를 연결하면 다음 중 하나를 사용하여 소스 코드가 포함된 GitHub 리포지토리에서 연결된 애플리케이션과 데이터베이스를 인스턴스화할 수 있습니다. oc get templates -n openshift:를 사용하여 사용 가능한 모든 템플릿을 나열할 수 있습니다.

CakePHP MySQL https://github.com/sclorg/cakephp-ex

- template: cakephp-mysql-example

Node.js MongoDB https://github.com/sclorg/nodejs-ex

- 템플릿: nodejs-mongodb-example

Django PosgreSQL https://github.com/sclorg/django-ex

- template: django-psql-example

Dancer MySQL https://github.com/sclorg/dancer-ex

- template: dancer-mysql-example

Rails PostgreSQL https://github.com/sclorg/rails-ex

- 템플릿: rails-postgresql-example

6.4.2. 워크플로우

위의 템플릿 URL 중 하나의 git clone 을 로컬로 실행합니다. 애플리케이션 소스 코드를 추가하고 커밋하고 GitHub 리포지토리를 푸시한 다음 위에 나열된 템플릿 중 하나에서 v3 빠른 시작 애플리케이션을 시작합니다.

- 애플리케이션용 GitHub 리포지토리를 생성합니다.

빠른 시작 템플릿을 복제하고 GitHub 리포지토리를 원격으로 추가합니다.

git clone <one-of-the-template-URLs-listed-above> cd <your local git repository> git remote add upstream <https://github.com/<git-id>/<quickstart-repo>.git> git push -u upstream master

$ git clone <one-of-the-template-URLs-listed-above> $ cd <your local git repository> $ git remote add upstream <https://github.com/<git-id>/<quickstart-repo>.git> $ git push -u upstream masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 소스 코드를 GitHub에 커밋하고 내보냅니다.

cd <your local repository> git commit -am “added code for my app” git push origin master

$ cd <your local repository> $ git commit -am “added code for my app” $ git push origin masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow v3에서 새 애플리케이션을 생성합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- MongoDB에만 적용됩니다.

이제 포드 2개, 웹 프레임워크 포드 및 데이터베이스 포드가 실행 중이어야 합니다. 웹 프레임워크 포드 환경은 데이터베이스 포드 환경과 일치해야 합니다.

oc set env pod/<pod_name> --list:로 환경 변수를 나열할 수 있습니다.-

DATABASE_NAME은 이제 <DB_SERVICE>_DATABASE -

DATABASE_USER이제 <DB_SERVICE>_USER -

DATABASE_PASSWORD이제 <DB_SERVICE>_PASSWORD DATABASE_ADMIN_PASSWORD는 이제MONGODB_ADMIN_PASSWORD(MongoDB에만 적용 가능)SOURCE_REPOSITORY_URL이 지정되지 않은 경우 템플릿은 위의 템플릿 URL(https://github.com/openshift/<quickstart>-ex)을 소스 리포지토리로 사용하고 hello-welcome 애플리케이션이 시작됩니다.

-

데이터베이스를 마이그레이션하는 경우 데이터베이스를 덤프 파일로 내보내고 새 v3 데이터베이스 Pod의 데이터베이스를 복원합니다. 데이터베이스 포드가 이미 시작되어 실행 중이므로 데이터베이스 애플리케이션 데이터베이스 애플리케이션에 설명된 단계를 참조하여

oc new-app단계를 건너뜁니다.

6.5. CI/CD(Continuous Integration and Deployment)

6.5.1. 개요

이 주제에서는 OpenShift 버전 2(v2)와 OpenShift 버전 3(v3) 간의 CI/CD(Continuous Integration and deployment) 애플리케이션의 차이점과 이러한 애플리케이션을 v3 환경으로 마이그레이션하는 방법을 검토합니다.

6.5.2. Jenkins

OpenShift 버전 2(v2) 및 OpenShift 버전 3(v3)의 Jenkins 애플리케이션은 아키텍처의 근본적인 차이로 인해 다르게 구성됩니다. 예를 들어, v2에서 애플리케이션은 소스 코드를 저장하기 위해 장치 내에 호스팅되는 통합 Git 리포지토리를 사용합니다. v3에서 소스 코드는 포드 외부에서 호스팅되는 퍼블릭 또는 프라이빗 Git 리포지토리에 있습니다.

또한 OpenShift v3에서는 소스 코드 변경으로 인해 Jenkins 작업을 트리거할 수 있을 뿐만 아니라 소스 코드와 함께 애플리케이션을 빌드하는 데 사용되는 이미지의 변경 사항인 ImageStream의 변경 사항도 사용할 수 있습니다. 따라서 v3에서 새 Jenkins 애플리케이션을 생성한 다음 OpenShift v3 환경에 적합한 구성으로 작업을 다시 생성하여 Jenkins 애플리케이션을 수동으로 마이그레이션하는 것이 좋습니다.

Jenkins 애플리케이션을 생성하고, 작업을 구성하고, Jenkins 플러그인을 적절하게 사용하는 방법에 대한 자세한 내용은 다음 리소스를 참조하십시오.

6.6. Webhook 및 작업 후크

6.6.1. 개요

이 주제에서는 OpenShift 버전 2(v2)와 OpenShift 버전 3(v3) 간의 웹 후크와 작업 후크의 차이점을 검토하고 이러한 애플리케이션을 v3 환경으로 마이그레이션하는 방법을 검토합니다.

6.6.2. Webhook

GitHub 리포지토리에서

BuildConfig를 생성한 후 다음을 실행합니다.oc describe bc/<name-of-your-BuildConfig>

$ oc describe bc/<name-of-your-BuildConfig>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 그러면 다음과 같은 Webhook GitHub URL이 출력됩니다.

<https://api.starter-us-east-1.openshift.com:443/oapi/v1/namespaces/nsname/buildconfigs/bcname/webhooks/secret/github>.

<https://api.starter-us-east-1.openshift.com:443/oapi/v1/namespaces/nsname/buildconfigs/bcname/webhooks/secret/github>.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - GitHub 웹 콘솔에서 이 URL을 잘라내어 GitHub에 붙여넣습니다.

- GitHub 리포지토리의 설정 → Webhook 및 서비스에서 Webhook 추가 를 선택합니다.

- URL 출력(위와 유사)을 Payload URL 필드에 붙여넣습니다.

-

Content Type 을

application/json으로 설정합니다. - Webhook 추가를 클릭합니다.

GitHub에서 Webhook가 성공적으로 구성되었음을 알리는 메시지가 표시됩니다.

이제 GitHub 리포지토리에 변경 사항을 푸시할 때마다 새 빌드가 자동으로 시작되고 빌드가 성공하면 새 배포가 시작됩니다.

애플리케이션을 삭제하거나 다시 생성하는 경우 GitHub의 Payload URL 필드를 새 BuildConfig Webhook URL로 업데이트해야 합니다.

6.6.3. 작업 후크

OpenShift 버전 2(v2)에는 .openshift/action_hooks 디렉터리에 있는 build, deploy, post_deploy, pre_build 스크립트 또는 action_hooks가 있습니다. v3에서 이러한 기능에 대한 일대일 매핑은 없지만 v3의 S2I 툴에 는 소스 리포지토리의 .s2i/bin 디렉터리에 사용자 지정 가능한 스크립트 를 추가할 수 있는 옵션이 있습니다.

OpenShift 버전 3(v3)은 이미지 빌드 후 및 레지스트리로 푸시되기 전에 이미지의 기본 테스트를 실행하기 위한 빌드 후 후크 도 제공합니다. 배포 후크 는 배포 구성에서 구성됩니다.

v2에서 action_hooks는 일반적으로 환경 변수를 설정하는 데 사용됩니다. v2에서는 다음을 사용하여 모든 환경 변수를 전달해야 합니다.

oc new-app <source-url> -e ENV_VAR=env_var

$ oc new-app <source-url> -e ENV_VAR=env_var또는 다음을 수행합니다.

oc new-app <template-name> -p ENV_VAR=env_var

$ oc new-app <template-name> -p ENV_VAR=env_var환경 변수도 다음을 사용하여 추가하거나 변경할 수 있습니다.

oc set env dc/<name-of-dc> ENV_VAR1=env_var1 ENV_VAR2=env_var2’

$ oc set env dc/<name-of-dc>

ENV_VAR1=env_var1 ENV_VAR2=env_var2’6.7. S2I 툴

6.7.1. 개요

S2I(Source-to-Image) 툴은 애플리케이션 소스 코드를 컨테이너 이미지에 삽입하고 최종 제품은 빌더 이미지와 빌드 소스 코드를 통합하는 즉시 실행할 준비가 된 컨테이너 이미지입니다. S2I 툴은 리포지터리에서 OpenShift Container Platform 없이 로컬 머신에 설치할 수 있습니다. https://github.com/openshift/source-to-image#installation

S2I 툴은 OpenShift Container Platform에서 사용하기 전에 애플리케이션 및 이미지를 로컬로 테스트하고 확인하는 매우 강력한 툴입니다.

6.7.2. 컨테이너 이미지 생성

- 애플리케이션에 필요한 빌더 이미지를 확인합니다. Red Hat은 Python, Ruby, Perl, PHP 및 Node.js 를 포함한 다양한 언어를 위한 여러 빌더 이미지를 제공합니다. 커뮤니티 공간에서 다른 이미지를 사용할 수 있습니다.

S2I는 로컬 파일 시스템의 소스 코드 또는 Git 리포지토리에서 이미지를 빌드할 수 있습니다. 빌더 이미지 및 소스 코드에서 새 컨테이너 이미지를 빌드하려면 다음을 수행합니다.

s2i build <source-location> <builder-image-name> <output-image-name>

$ s2i build <source-location> <builder-image-name> <output-image-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고<source-location>은 Git 리포지토리 URL 또는 로컬 파일 시스템의 소스 코드일 수 있습니다.Docker 데몬을 사용하여 빌드 이미지를 테스트합니다.

docker run -d --name <new-name> -p <port-number>:<port-number> <output-image-name> curl localhost:<port-number>

$ docker run -d --name <new-name> -p <port-number>:<port-number> <output-image-name> $ curl localhost:<port-number>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 새 이미지를 OpenShift 레지스트리에 내보냅니다.

oc명령을 사용하여 OpenShift 레지스트리의 이미지에서 새 애플리케이션을 생성합니다.oc new-app <image-name>

$ oc new-app <image-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.8. 기술 지원 가이드

6.8.1. 개요

이 주제에서는 OpenShift 버전 2(v2) 및 OpenShift 버전 3(v3)에서 지원되는 언어, 프레임워크, 데이터베이스 및 마커를 검토합니다.

OpenShift Container Platform 고객이 사용하는 일반적인 조합에 대한 자세한 내용은 OpenShift Container Platform 테스트 통합을 참조하십시오.

6.8.2. 지원되는 데이터베이스

데이터베이스 응용 프로그램 항목의 지원되는 데이터베이스 섹션을 참조하십시오.

6.8.3. 지원되는 언어

6.8.4. 지원되는 프레임워크

| v2 | v3 |

|---|---|

| Jenkins 서버 | jenkins-persistent |

| 드루팔 7 | |

| 유령 0.7.5 | |

| WordPress 4 | |

| Ceylon | |

| Go | |

| MEAN |

6.8.5. 지원되는 마크커

| v2 | v3 |

|---|---|

| pip_install | 리포지토리에 requirements.txt 가 포함된 경우 기본적으로 pip가 호출됩니다. 그렇지 않으면 pip를 사용하지 않습니다. |

| v2 | v3 |

|---|---|

| disable_asset_compilation |

이 작업은 buildconfig 전략 정의에서 |

| v2 | v3 |

|---|---|

| enable_cpan_tests |

이 작업은 빌드 구성에서 |

| v2 | v3 |

|---|---|

| use_composer | 소스 리포지토리에 root 디렉터리에 composer.json 이 포함된 경우 composer가 항상 사용됩니다. |

| v2 | v3 |

|---|---|

| NODEJS_VERSION | 해당 없음 |

| use_npm |

IKEv |

| v2 | v3 |

|---|---|

| enable_debugging |

이 옵션은 비어 있지 않은 값으로 설정하여 배포 구성에 설정된 |

| skip_maven_build | pom.xml 이 있으면 maven이 실행됩니다. |

| java7 | 해당 없음 |

| java8 | JavaEE는 JDK8을 사용합니다. |

| v2 | v3 |

|---|---|

| enable_debugging | 해당 없음 |

| v2 | v3 |

|---|---|

| force_clean_build | buildconfig 의 noCache 필드로 v3에는 유사한 개념이 있으므로 컨테이너를 빌드하여 각 계층을 다시 실행합니다. S2I 빌드에서 incremental 플래그는 기본적으로 false이며 이는 정리된 빌드 를 나타냅니다. |

| hot_deploy | |

| enable_public_server_status | 해당 없음 |

| disable_auto_scaling | 자동 스케일링은 기본적으로 비활성화되어 Pod 자동 스케일링 을 통해 설정할 수 있습니다. |

6.8.6. 지원되는 환경 변수

7장. 튜토리얼

7.1. 개요

이 주제 그룹에는 OpenShift Container Platform에서 애플리케이션을 가동 및 실행하는 방법에 대한 정보가 포함되어 있으며 다양한 언어와 프레임워크를 다룹니다.

7.2. 빠른 시작 템플릿

7.2.1. 개요

빠른 시작은 OpenShift Container Platform에서 실행되는 애플리케이션의 기본 예입니다. 빠른 시작은 다양한 언어와 프레임워크로 제공되며 일련의 서비스, 빌드 구성 및 배포 구성으로 구성된 템플릿에 정의됩니다. 이 템플릿은 애플리케이션을 빌드하고 배포하는 데 필요한 이미지 및 소스 리포지터리를 참조합니다.

빠른 시작을 살펴보려면 템플릿에서 애플리케이션을 만듭니다. 관리자가 이미 OpenShift Container Platform 클러스터에 이러한 템플릿을 이미 설치했을 수 있으며, 이 경우 간단히 웹 콘솔에서 선택할 수 있습니다. 템플릿 업로드, 생성, 템플릿 수정 방법에 대한 자세한 내용은 템플릿 설명서를 참조하십시오.

빠른 시작은 애플리케이션 소스 코드가 포함된 소스 리포지터리를 참조합니다. 빠른 시작을 사용자 지정하려면 리포지토리를 포크하고 템플릿에서 애플리케이션을 생성할 때 기본 소스 리포지토리 이름을 포크된 리포지토리로 대체합니다. 그러면 제공된 소스 예 대신 소스 코드를 사용하여 수행되는 빌드가 생성됩니다. 그런 다음, 소스 리포지터리에서 코드를 업데이트하고 새 빌드를 시작하여 배포된 애플리케이션에 변경 사항이 반영된 것을 확인할 수 있습니다.

7.2.2. 웹 프레임워크 빠른 시작 템플릿

이러한 빠른 시작은 표시된 프레임워크 및 언어의 기본 애플리케이션을 제공합니다.

7.3. Ruby on Rails

7.3.1. 개요

Ruby on Rails는 Ruby 로 작성된 인기 있는 웹 프레임워크입니다. 이 안내서에서는 OpenShift Container Platform에서 Rails 4를 사용하는 방법을 설명합니다.

OpenShift Container Platform에서 애플리케이션을 실행하는 데 필요한 모든 단계에 대한 개요를 보려면 전체 튜토리얼을 통해 안내해 드립니다. 문제가 발생하면 전체 자습서를 읽어보고 다시 돌아가 문제를 해결하십시오. 이전 단계를 검토하여 모든 단계가 제대로 실행되었는지 확인하는 것도 유용할 수 있습니다.

이 가이드에서는 다음이 필요합니다.For this guide, you will need:

- 기본 Ruby/Rails 지식

- 로컬로 설치된 Ruby 2.0.0+, Rubygems, Bundler 버전

- 기본 Git 지식

- OpenShift Container Platform v3의 인스턴스 실행

7.3.2. 로컬 워크스테이션 설정

먼저 OpenShift Container Platform 인스턴스가 실행 중이고 사용 가능한지 확인합니다. OpenShift Container Platform을 가동하고 실행하는 방법에 대한 자세한 내용은 설치 방법을 확인하십시오. 또한 oc CLI 클라이언트가 설치되어 있고 명령 쉘에서 명령에 액세스할 수 있으므로 이메일 주소와 암호로 로그인 할 수 있습니다.

7.3.2.1. 데이터베이스 설정

Rails 애플리케이션은 거의 항상 데이터베이스와 함께 사용됩니다. 로컬 개발을 위해 PostgreSQL 데이터베이스를 선택했습니다. 설치 유형:

sudo yum install -y postgresql postgresql-server postgresql-devel

$ sudo yum install -y postgresql postgresql-server postgresql-devel다음으로 데이터베이스를 초기화해야 합니다.

sudo postgresql-setup initdb

$ sudo postgresql-setup initdb

이 명령은 데이터를 저장할 /var/lib/pgsql/data 디렉토리를 생성합니다.

다음을 입력하여 데이터베이스를 시작합니다.

sudo systemctl start postgresql.service

$ sudo systemctl start postgresql.service

데이터베이스가 실행 중이면 rails 사용자를 생성합니다.

sudo -u postgres createuser -s rails

$ sudo -u postgres createuser -s rails이전에 만든 사용자는 암호가 없습니다.

7.3.3. 애플리케이션 작성

Rails 애플리케이션을 처음부터 시작하는 경우 Rails gem을 먼저 설치해야 합니다.

gem install rails Successfully installed rails-4.2.0 1 gem installed

$ gem install rails

Successfully installed rails-4.2.0

1 gem installedRails gem을 설치한 후 PostgreSQL을 데이터베이스로 사용하여 새 애플리케이션을 생성합니다.

rails new rails-app --database=postgresql

$ rails new rails-app --database=postgresql그런 다음 새 애플리케이션 디렉터리로 변경합니다.

cd rails-app

$ cd rails-app

이미 애플리케이션이 있으면 pg(postgresql) gem이 Gemfile에 있는지 확인합니다. gem을 추가하여 Gemfile 을 편집하지 않는 경우:

gem 'pg'

gem 'pg'

종속 항목이 모두 포함된 새 Gemfile.lock 을 생성하려면 다음을 실행합니다.

bundle install

$ bundle install

pg gem과 함께 postgresql 데이터베이스를 사용하는 것 외에도 config/database.yml 에서 postgresql 어댑터를 사용하고 있는지 확인해야 합니다.

config/database.yml 파일의 default 섹션이 다음과 같이 표시되도록 업데이트되었는지 확인합니다.

다음 rake 명령을 사용하여 애플리케이션의 개발 및 테스트 데이터베이스를 생성합니다.

rake db:create

$ rake db:create

PostgreSQL 서버에 development 및 test 데이터베이스가 생성됩니다.

7.3.3.1. 시작 페이지 만들기

Rails 4는 더 이상 프로덕션에서 정적 public/index.html 페이지를 제공하지 않으므로 새 루트 페이지를 생성해야 합니다.

사용자 정의 시작 페이지를 사용하려면 다음 단계를 수행해야 합니다.

- 인덱스 작업을 사용하여 컨트롤러 생성

-

welcome컨트롤러index작업의 뷰 페이지 생성 - 생성된 컨트롤러 및 뷰를 통해 애플리케이션 루트 페이지를 제공할 경로 생성

Rails는 이 모든 필요한 단계를 수행하는 생성기를 제공합니다.

rails generate controller welcome index

$ rails generate controller welcome index

필요한 모든 파일이 생성되었으며, 이제 config/routes.rb 파일에서 행 2를 다음과 같이 편집해야 합니다.

root 'welcome#index'

root 'welcome#index'rails 서버를 실행하여 페이지를 사용할 수 있는지 확인합니다.

rails server

$ rails server브라우저에서 http://localhost:3000으로 가서 페이지를 확인해야 합니다. 페이지가 표시되지 않으면 서버로 출력되는 로그를 확인하여 디버그합니다.

7.3.3.2. OpenShift Container Platform용 애플리케이션 구성

OpenShift Container Platform에서 실행할 PostgreSQL 데이터베이스 서비스와 통신하는 애플리케이션을 사용하려면 데이터베이스 서비스 생성 시 나중에 정의할 환경 변수 을 사용하도록 config/database.yml 의 default 섹션을 편집해야 합니다.

사전 정의된 변수와 함께 편집한 config/database.yml 의 default 섹션은 다음과 같아야 합니다.

최종 파일을 찾는 방법의 예는 Ruby on Rails 예제 application config/database.yml 을 참조하십시오.

7.3.3.3. Git에 애플리케이션 저장

OpenShift Container Platform에는 git 이 필요합니다. 설치되어 있지 않은 경우 설치해야 합니다.

OpenShift Container Platform에서 애플리케이션을 빌드하려면 일반적으로 소스 코드를 git 리포지토리에 저장해야 하므로 git 이 아직 없는 경우 설치해야 합니다.

ls -1 명령을 실행하여 Rails 애플리케이션 디렉토리에 있는지 확인합니다. 명령 출력은 다음과 같아야 합니다.

이제 Rails 앱 디렉토리에서 다음 명령을 실행하여 코드를 초기화하고 git으로 커밋합니다.

git init git add . git commit -m "initial commit"

$ git init

$ git add .

$ git commit -m "initial commit"애플리케이션이 커밋되면 원격 리포지토리로 내보내야 합니다. 이를 위해 새 리포지토리를 생성하는 GitHub 계정이 필요합니다.

git 리포지터리를 가리키는 remote를 설정합니다.

git remote add origin git@github.com:<namespace/repository-name>.git

$ git remote add origin git@github.com:<namespace/repository-name>.git그런 다음 애플리케이션을 원격 Git 리포지토리로 푸시합니다.

git push

$ git push7.3.4. OpenShift Container Platform에 애플리케이션 배포

Ruby on Rails 애플리케이션을 배포하려면 애플리케이션을 위한 새 프로젝트를 생성합니다.

oc new-project rails-app --description="My Rails application" --display-name="Rails Application"

$ oc new-project rails-app --description="My Rails application" --display-name="Rails Application"

rails-app 프로젝트를 생성하면 자동으로 새 프로젝트 네임스페이스로 전환됩니다.

OpenShift Container Platform에서 애플리케이션을 배포하려면 다음 세 단계를 수행해야 합니다.

- OpenShift Container Platform의 PostgreSQL 이미지에서데이터베이스 서비스 생성

- 데이터베이스 서비스와 연결하여 OpenShift Container Platform의 Ruby 2.0 빌더 이미지와 Ruby on Rails 소스 코드에서 프런트 엔드 서비스 생성

- 애플리케이션 경로를 생성합니다.

7.3.4.1. 데이터베이스 서비스 생성

Rails 애플리케이션에 실행 중인 데이터베이스 서비스가 필요합니다. 이 서비스에는 PostgeSQL 데이터베이스 이미지 를 사용합니다.

데이터베이스 서비스를 생성하려면 oc new-app 명령을 사용합니다. 데이터베이스 컨테이너 내에서 사용할 몇 가지 필요한 환경 변수를 이 명령으로 전달해야 합니다. 이러한 환경 변수는 사용자 이름, 암호 및 데이터베이스 이름을 설정하는 데 필요합니다. 이러한 환경 변수 의 값을 원하는 대로 변경할 수 있습니다. 설정할 변수는 다음과 같습니다.

- POSTGRESQL_DATABASE

- POSTGRESQL_USER

- POSTGRESQL_PASSWORD

이러한 변수를 설정하면 다음과 같은 결과를 얻을 수 있습니다.

- 지정된 이름의 데이터베이스가 있습니다.

- 지정된 이름의 사용자가 있습니다.

- 사용자가 지정된 암호를 사용하여 지정된 데이터베이스에 액세스할 수 있습니다.

예를 들어 다음과 같습니다.

oc new-app postgresql -e POSTGRESQL_DATABASE=db_name -e POSTGRESQL_USER=username -e POSTGRESQL_PASSWORD=password

$ oc new-app postgresql -e POSTGRESQL_DATABASE=db_name -e POSTGRESQL_USER=username -e POSTGRESQL_PASSWORD=password데이터베이스 관리자의 암호도 설정하려면 다음 행을 이전 명령에 추가합니다.

-e POSTGRESQL_ADMIN_PASSWORD=admin_pw