This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.서버리스

OpenShift 서버리스 설치, 사용법, 릴리스 정보

초록

1장. 릴리스 노트

OpenShift Serverless 라이프 사이클 및 지원되는 플랫폼에 대한 자세한 내용은 플랫폼 라이프 사이클 정책을 참조하십시오.

릴리스 노트에는 새로운 기능 및 더 이상 사용되지 않는 기능, 변경 사항 중단 및 알려진 문제에 대한 정보가 포함되어 있습니다. 다음 릴리스 노트는 OpenShift Container Platform의 최신 OpenShift Serverless 릴리스에 적용됩니다.

OpenShift Serverless 기능에 대한 개요는 OpenShift Serverless 정보를 참조하십시오.

OpenShift Serverless는 오픈 소스 Knative 프로젝트를 기반으로 합니다.

최신 Knative 구성 요소 릴리스에 대한 자세한 내용은 Knative 블로그를 참조하십시오.

1.1. API 버전 정보

API 버전은 OpenShift Serverless에서 특정 기능 및 사용자 정의 리소스의 개발 상태에 대한 중요한 측정입니다. 올바른 API 버전을 사용하지 않는 클러스터에서 리소스를 생성하면 배포에 문제가 발생할 수 있습니다.

OpenShift Serverless Operator는 최신 버전을 사용하기 위해 더 이상 사용되지 않는 API를 사용하는 이전 리소스를 자동으로 업그레이드합니다. 예를 들어 v1beta1과 같은 이전 ApiServerSource API 버전을 사용하는 리소스를 클러스터에 생성한 경우 OpenShift Serverless Operator는 사용 가능하고 v1beta1 버전이 더 이상 사용되지 않을 때 API의 v1 버전을 사용하도록 이러한 리소스를 자동으로 업데이트합니다.

더 이상 사용되지 않는 API의 이전 버전은 향후 릴리스에서 제거될 수 있습니다. 더 이상 사용되지 않는 API 버전을 사용해도 리소스가 실패하지 않습니다. 그러나 제거된 API 버전을 사용하려고 하면 리소스가 실패합니다. 문제를 방지하기 위해 최신 버전을 사용하도록 매니페스트가 업데이트되었는지 확인합니다.

1.2. 일반적으로 사용 가능 및 기술 프리뷰 기능

일반적으로 사용 가능한 기능(GA)이 완전히 지원되며 프로덕션용으로 적합합니다.Features that are general Available (GA) are fully supported and are suitable for production use. 기술 프리뷰(TP) 기능은 실험적인 기능이며 프로덕션용이 아닙니다. TP 기능에 대한 자세한 내용은 Red Hat 고객 포털에서 기술 프리뷰 지원 범위를 참조하십시오.

다음 표에서는 GA 및 TP인 OpenShift Serverless 기능에 대한 정보를 제공합니다.

| 기능 | 1.26 | 1.27 | 1.28 |

|---|---|---|---|

|

| GA | GA | GA |

| Quarkus 함수 | GA | GA | GA |

| Node.js 함수 | TP | TP | GA |

| TypeScript 함수 | TP | TP | GA |

| Python 함수 | - | - | TP |

| 서비스 메시 mTLS | GA | GA | GA |

|

| GA | GA | GA |

| HTTPS 리디렉션 | GA | GA | GA |

| Kafka 브로커 | GA | GA | GA |

| Kafka 싱크 | GA | GA | GA |

| Knative 서비스에 대한 init 컨테이너 지원 | GA | GA | GA |

| Knative 서비스에 대한 PVC 지원 | GA | GA | GA |

| 내부 트래픽의 경우 TLS | TP | TP | TP |

| 네임스페이스 범위 브로커 | - | TP | TP |

|

| - | - | TP |

1.3. 사용되지 않거나 삭제된 기능

이전 릴리스에서 일반적으로 사용 가능한 (GA) 또는 기술 프리뷰 (TP)인 일부 기능은 더 이상 사용되지 않거나 삭제되었습니다. 더 이상 사용되지 않는 기능은 여전히 OpenShift Serverless에 포함되어 있으며 계속 지원됩니다. 그러나 이 기능은 향후 릴리스에서 제거될 예정이므로 새로운 배포에는 사용하지 않는 것이 좋습니다.

OpenShift Serverless에서 더 이상 사용되지 않고 삭제된 주요 기능의 최신 목록은 다음 표를 참조하십시오.

| 기능 | 1.20 | 1.21 | 1.22 ~ 1.26 | 1.27 | 1.28 |

|---|---|---|---|---|---|

|

| 더 이상 사용되지 않음 | 더 이상 사용되지 않음 | 제거됨 | 제거됨 | 제거됨 |

|

| 더 이상 사용되지 않음 | 제거됨 | 제거됨 | 제거됨 | 제거됨 |

|

서비스 및 Eventing | - | - | - | 더 이상 사용되지 않음 | 더 이상 사용되지 않음 |

|

| - | - | - | - | 더 이상 사용되지 않음 |

1.4. Red Hat OpenShift Serverless 1.28 릴리스 노트

OpenShift Serverless 1.28이 출시되었습니다. 이 항목에는 OpenShift Container Platform의 OpenShift Serverless와 관련된 새로운 기능, 변경 사항, 알려진 문제가 포함되어 있습니다.

1.4.1. 새로운 기능

- OpenShift Serverless에서 Knative Serving 1.7을 사용합니다.

- OpenShift Serverless에서 Knative Eventing 1.7을 사용합니다.

- OpenShift Serverless에서 Kourier 1.7을 사용합니다.

-

OpenShift Serverless에서 Knative(

kn) CLI 1.7을 사용합니다. - OpenShift Serverless에서 Knative Kafka 1.7을 사용합니다.

-

kn funcCLI 플러그인은 이제func1.9.1 버전을 사용합니다. - 이제 OpenShift Serverless Functions의 node.js 및 TypeScript 런타임을 GA(일반 사용 가능)로 사용할 수 있습니다.

- OpenShift Serverless Functions의 Python 런타임은 이제 기술 프리뷰로 사용할 수 있습니다.

- Knative Serving에 대한 멀티컨테이너 지원을 기술 프리뷰로 사용할 수 있습니다. 이 기능을 사용하면 단일 Knative 서비스를 사용하여 멀티컨테이너 Pod를 배포할 수 있습니다.

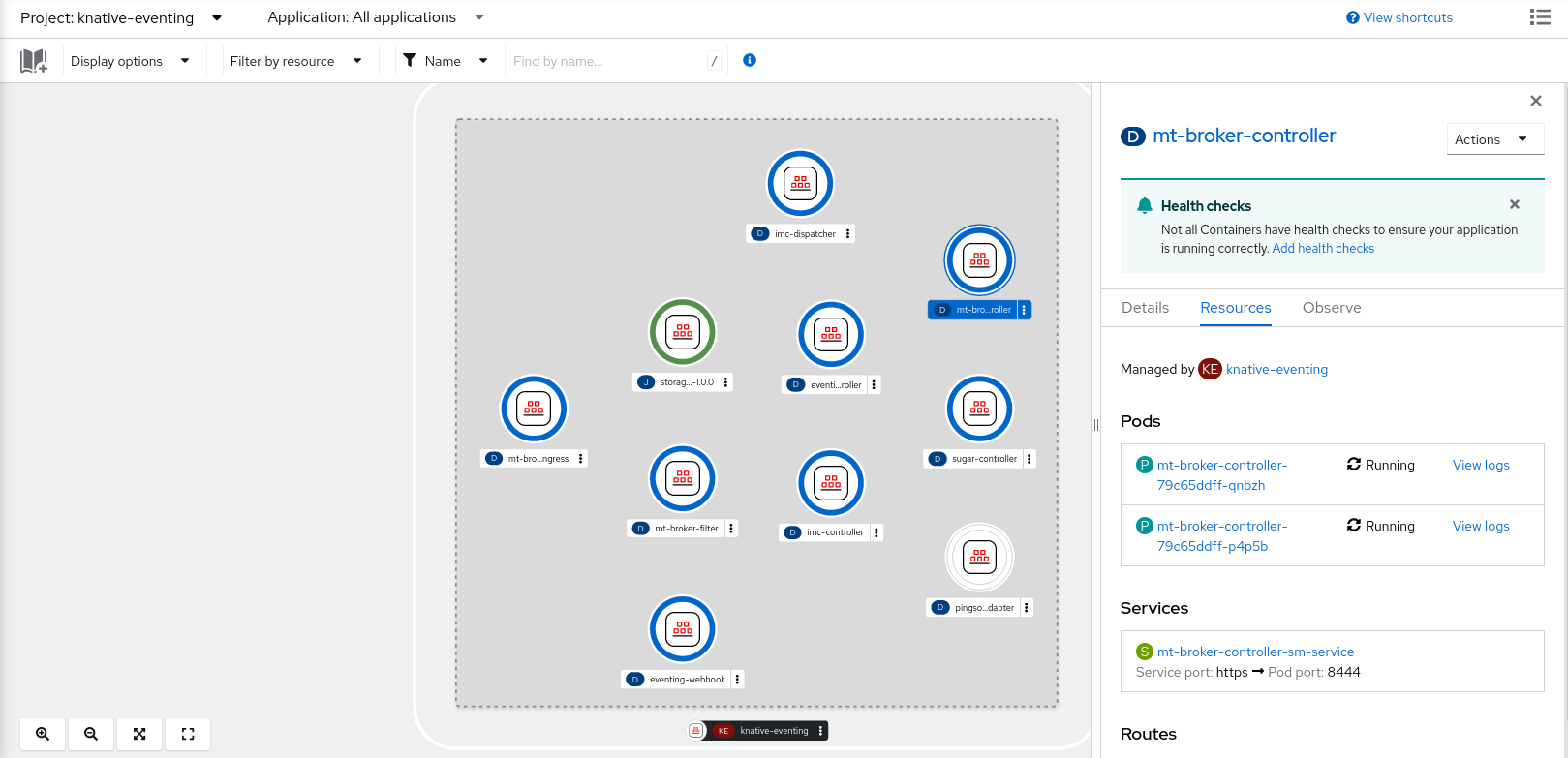

OpenShift Serverless 1.29 이상에서는 Knative Eventing의 다음 구성 요소가 두 Pod에서 하나로 축소됩니다.

-

imc-controller -

imc-dispatcher -

mt-broker-controller -

mt-broker-filter -

mt-broker-ingress

-

Serving CR에 대한

서버리스.openshift.io/enable-secret-informer-filtering주석이 더 이상 사용되지 않습니다. 주석은 Istio에만 유효하며 Kourier에는 유효하지 않습니다.OpenShift Serverless 1.28을 사용하면 OpenShift Serverless Operator에서

net-istio및net-kourier모두에 환경 변수ENABLE_SECRET_INFORMER_FILTERING_BY_CERT_UID를 삽입할 수 있습니다.시크릿 필터링을 활성화하면 모든 시크릿에

networking.internal.knative.dev/certificate-uid: "<id>"로 레이블이 지정됩니다. 그러지 않으면 Knative Serving에서 이를 탐지하지 않아 오류가 발생합니다. 새 시크릿과 기존 보안의 라벨을 모두 지정해야 합니다.다음 OpenShift Serverless 릴리스 중 하나에서 시크릿 필터링은 기본적으로 활성화됩니다. 오류를 방지하려면 시크릿에 미리 레이블을 지정합니다.

1.4.2. 확인된 문제

현재 IBM Power, IBM zSystems 및 IBM® LinuxONE의 OpenShift Serverless Functions에서는 Python에 대한 런타임이 지원되지 않습니다.

이러한 아키텍처에서 node.js, TypeScript 및 Quarkus 함수가 지원됩니다.

Windows 플랫폼에서는

app.sh파일 권한으로 Source-to-Image 빌더를 사용하여 Python 함수를 로컬로 빌드, 실행 또는 배포할 수 없습니다.이 문제를 해결하려면 Linux용 Windows를 사용하십시오.

1.5. Red Hat OpenShift Serverless 1.27 릴리스 노트

OpenShift Serverless 1.27이 출시되었습니다. 이 항목에는 OpenShift Container Platform의 OpenShift Serverless와 관련된 새로운 기능, 변경 사항, 알려진 문제가 포함되어 있습니다.

OpenShift Serverless 1.26은 OpenShift Container Platform 4.12에서 완전하게 지원되는 초기 릴리스입니다. OpenShift Serverless 1.25 이상은 OpenShift Container Platform 4.12에 배포되지 않습니다.

따라서 OpenShift Container Platform을 버전 4.12로 업그레이드하기 전에 먼저 OpenShift Serverless를 버전 1.26 또는 1.27로 업그레이드합니다.

1.5.1. 새로운 기능

- OpenShift Serverless에서 Knative Serving 1.6을 사용합니다.

- OpenShift Serverless에서 Knative Eventing 1.6을 사용합니다.

- OpenShift Serverless에서 Kourier 1.6을 사용합니다.

-

OpenShift Serverless에서 Knative(

kn) CLI 1.6을 사용합니다. - OpenShift Serverless에서 Knative Kafka 1.6을 사용합니다.

-

kn funcCLI 플러그인은 이제func1.8.1을 사용합니다. - 네임스페이스 범위 브로커를 이제 기술 프리뷰로 사용할 수 있습니다. 예를 들어 이러한 브로커를 사용하여 RBAC(역할 기반 액세스 제어) 정책을 구현할 수 있습니다.

-

KafkaSink는 기본적으로CloudEvent바이너리 콘텐츠 모드를 사용합니다. 바이너리 콘텐츠 모드는CloudEvent대신 본문에서 헤더를 사용하므로 구조화된 모드보다 효율적입니다. 예를 들어 HTTP 프로토콜의 경우 HTTP 헤더를 사용합니다. - OpenShift Container Platform 4.10 이상의 OpenShift 경로를 사용하여 외부 트래픽에 HTTP/2 프로토콜을 통해 gRPC 프레임워크를 사용할 수 있습니다. 이를 통해 클라이언트와 서버 간의 통신 효율성과 속도가 향상됩니다.

-

Knative Operator Serving 및 Eventings CRD의 API 버전

v1alpha1은 1.27에서 더 이상 사용되지 않습니다. 이는 향후 버전에서 제거될 예정입니다. Red Hat은 대신v1beta1버전을 사용할 것을 권장합니다. Serverless Operator를 업그레이드할 때 CRD가 자동으로 업데이트되므로 기존 설치에 영향을 미치지 않습니다. - 이제 제공 시간 초과 기능이 기본적으로 활성화되어 있습니다. 이를 통해 전송된 각 HTTP 요청에 대한 시간 초과를 지정할 수 있습니다. 이 기능은 기술 프리뷰로 남아 있습니다.

1.5.2. 해결된 문제

-

이전 버전에서는 Knative 서비스가

Ready상태가 되어 로드 밸런서가 준비될 때까지 대기 중인 것으로 보고하는 경우가 있었습니다. 이 문제가 해결되었습니다.

1.5.3. 확인된 문제

-

OpenShift Serverless를 Red Hat OpenShift Service Mesh와 통합하면 클러스터에 보안이 너무 많으면

net-kourierPod가 시작 시 메모리 부족이 발생합니다. 네임스페이스 범위 브로커는 네임스페이스 범위 브로커를 삭제한 후에도 사용자 네임스페이스에서

ClusterRoleBinding을종료할 수 있습니다.이 경우 사용자 네임스페이스에서

rbac-proxy-reviews-prom-rb-knative-kafka-broker-data-plane-{{.Namespace}}이라는ClusterRoleBinding을 삭제합니다.Ingress에

net-istio를 사용하고security.dataPlane.mtls: true를 사용하여 SMCP를 통해 mTLS를 활성화하는 경우 Service Mesh는 OpenShift Serverless에 대한DomainMapping을 허용하지 않는*.local호스트에 대한DestinationRule을 배포합니다.이 문제를 해결하려면

security.dataPlane.mtls: true를 사용하는 대신PeerAuthentication을 배포하여 mTLS를 활성화합니다.

1.6. Red Hat OpenShift Serverless 1.26 릴리스 노트

OpenShift Serverless 1.26이 공개되었습니다. 이 항목에는 OpenShift Container Platform의 OpenShift Serverless와 관련된 새로운 기능, 변경 사항, 알려진 문제가 포함되어 있습니다.

1.6.1. 새로운 기능

- Quarkus를 사용하는 OpenShift Serverless Functions가 이제 GA입니다.

- OpenShift Serverless에서 Knative Serving 1.5를 사용합니다.

- OpenShift Serverless에서 Knative Eventing 1.5를 사용합니다.

- OpenShift Serverless에서 Kourier 1.5를 사용합니다.

-

OpenShift Serverless에서 Knative(

kn) CLI 1.5를 사용합니다. - OpenShift Serverless에서 Knative Kafka 1.5를 사용합니다.

- OpenShift Serverless에서 Knative Operator 1.3을 사용합니다.

-

kn funcCLI 플러그인에서func1.8.1을 사용합니다. - PVC(영구 볼륨 클레임)는 이제 GA입니다. PVC는 Knative 서비스에 영구 데이터 스토리지를 제공합니다.

새로운 트리거 필터 기능을 이제 개발자 프리뷰로 사용할 수 있습니다. 이를 통해 사용자는 필터 표현식 세트를 지정할 수 있으며 각 표현식은 각 이벤트에 대해 true 또는 false로 평가됩니다.

새 트리거 필터를 활성화하려면 Operator 구성 맵의

KnativeEventing유형의 섹션에new-trigger-filters: enabled항목을 추가합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow Knative Operator 1.3은

operator.knative.dev용으로 API의 업데이트된v1beta1버전을 추가합니다.KnativeServing및KnativeEventing사용자 정의 리소스 구성 맵의v1alpha1에서v1beta1로 업데이트하려면apiVersion키를 편집합니다.KnativeServing사용자 정의 리소스 구성 맵의 예apiVersion: operator.knative.dev/v1beta1 kind: KnativeServing ...

apiVersion: operator.knative.dev/v1beta1 kind: KnativeServing ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow KnativeEventing사용자 정의 리소스 구성 맵의 예apiVersion: operator.knative.dev/v1beta1 kind: KnativeEventing ...

apiVersion: operator.knative.dev/v1beta1 kind: KnativeEventing ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6.2. 해결된 문제

- 이전에는 Kafka 브로커, Kafka 소스 및 Kafka 싱크에서 FIPS(Federal Information Processing Standards) 모드가 비활성화되었습니다. 이 문제가 해결되었으며 이제 FIPS 모드를 사용할 수 있습니다.

1.6.3. 확인된 문제

Ingress에

net-istio를 사용하고security.dataPlane.mtls: true를 사용하여 SMCP를 통해 mTLS를 활성화하는 경우 Service Mesh는 OpenShift Serverless에 대한DomainMapping을 허용하지 않는*.local호스트에 대한DestinationRule을 배포합니다.이 문제를 해결하려면

security.dataPlane.mtls: true를 사용하는 대신PeerAuthentication을 배포하여 mTLS를 활성화합니다.

1.7. Red Hat OpenShift Serverless 1.25.0 릴리스 노트

OpenShift Serverless 1.25.0이 공개되었습니다. 이 항목에는 OpenShift Container Platform의 OpenShift Serverless와 관련된 새로운 기능, 변경 사항, 알려진 문제가 포함되어 있습니다.

1.7.1. 새로운 기능

- OpenShift Serverless에서 Knative Serving 1.4를 사용합니다.

- OpenShift Serverless에서 Knative Eventing 1.4를 사용합니다.

- OpenShift Serverless에서 Kourier 1.4를 사용합니다.

-

OpenShift Serverless에서 Knative(

kn) CLI 1.4를 사용합니다. - OpenShift Serverless에서 Knative Kafka 1.4를 사용합니다.

-

kn funcCLI 플러그인에서func1.7.0을 사용합니다. - 함수 생성 및 배포를 위한 IDE(통합 개발 환경) 플러그인을 이제 Visual Studio Code 및 IntelliJ 에서 사용할 수 있습니다.

Knative Kafka 브로커는 이제 GA입니다. Knative Kafka 브로커는 Apache Kafka를 직접 대상으로 하는 Knative 브로커 API의 고성능 구현입니다.

MT-Channel-Broker를 사용하지 않는 것이 좋지만 Knative Kafka 브로커를 대신 사용하지 않는 것이 좋습니다.

-

Knative Kafka 싱크는 이제 GA입니다.

KafkaSink는CloudEvent를 사용하여 Apache Kafka 주제로 보냅니다. 이벤트는 구조화된 또는 바이너리 콘텐츠 모드로 지정할 수 있습니다. - 내부 트래픽에 대한 TLS 활성화가 기술 프리뷰로 제공됩니다.

1.7.2. 해결된 문제

- 이전 버전에서는 활성 상태 프로브가 실패한 후 컨테이너를 재시작한 경우 Knative Serving에 준비 상태 프로브가 실패한 문제가 있었습니다. 이 문제가 해결되었습니다.

1.7.3. 확인된 문제

- Kafka 브로커, Kafka 소스 및 Kafka 싱크에 대해 연방 정보 처리 표준(FIPS) 모드가 비활성화되어 있습니다.

-

SinkBinding오브젝트는 서비스에 대한 사용자 정의 리버전 이름을 지원하지 않습니다. Knative Serving 컨트롤러 Pod는 클러스터의 시크릿을 감시하기 위해 새로운 정보원을 추가합니다. informer에는 캐시에 시크릿이 포함되어 있으므로 컨트롤러 Pod의 메모리 사용량이 증가합니다.

Pod가 메모리가 부족하면 배포의 메모리 제한을 늘려 문제를 해결할 수 있습니다.

Ingress에

net-istio를 사용하고security.dataPlane.mtls: true를 사용하여 SMCP를 통해 mTLS를 활성화하는 경우 Service Mesh는 OpenShift Serverless에 대한DomainMapping을 허용하지 않는*.local호스트에 대한DestinationRule을 배포합니다.이 문제를 해결하려면

security.dataPlane.mtls: true를 사용하는 대신PeerAuthentication을 배포하여 mTLS를 활성화합니다.

1.8. Red Hat OpenShift Serverless 1.24.0 릴리스 정보

OpenShift Serverless 1.24.0을 사용할 수 있습니다. 이 항목에는 OpenShift Container Platform의 OpenShift Serverless와 관련된 새로운 기능, 변경 사항, 알려진 문제가 포함되어 있습니다.

1.8.1. 새로운 기능

- OpenShift Serverless에서 Knative Serving 1.3을 사용합니다.

- OpenShift Serverless에서 Knative Eventing 1.3을 사용합니다.

- OpenShift Serverless에서 Kourier 1.3을 사용합니다.

-

OpenShift Serverless에서 Knative

knCLI 1.3을 사용합니다. - OpenShift Serverless에서 Knative Kafka 1.3을 사용합니다.

-

kn funcCLI 플러그인에서func0.24를 사용합니다. - 이제 Knative 서비스에 대한 init 컨테이너 지원을 일반적으로 사용할 수 있습니다(GA).

- OpenShift Serverless 논리를 개발자 프리뷰로 사용할 수 있습니다. 서버리스 애플리케이션을 관리하기 위한 선언적 워크플로 모델을 정의할 수 있습니다.

- 이제 OpenShift Serverless에서 비용 관리 서비스를 사용할 수 있습니다.

1.8.2. 해결된 문제

OpenShift Serverless를 Red Hat OpenShift Service Mesh와 통합하면 클러스터에 너무 많은 시크릿이 있을 때

net-istio-controllerpod가 시작 시 메모리 부족으로 실행됩니다.이제

net-istio-controller가networking.internal.knative.dev/certificate-uid레이블이 있는 보안만 고려하도록 하여 필요한 메모리 양을 줄일 수 있습니다.- OpenShift Serverless Functions Technology Preview에서는 이제 기본적으로 Cloud Native Buildpacks 를 사용하여 컨테이너 이미지를 빌드합니다.

1.8.3. 확인된 문제

- Kafka 브로커, Kafka 소스 및 Kafka 싱크에 대해 연방 정보 처리 표준(FIPS) 모드가 비활성화되어 있습니다.

OpenShift Serverless 1.23에서 KafkaBinding을 지원하고

kafka-bindingWebhook가 제거되었습니다. 그러나 기존kafkabindings.webhook.kafka.sources.knative.dev MutatingWebhookConfiguration은 더 이상 존재하지 않는kafka-source-webhook서비스를 가리키는 남아 있을 수 있습니다.클러스터의 KafkaBindings의 특정 사양에 대해

kafkabindings.webhook.kafka.sources.knative.dev MutatingWebhookConfiguration은 생성 및 업데이트 이벤트를(예: Deployments, Knative 서비스 또는 Jobs)에 전달하도록 구성할 수 있습니다. 그러면 Webhook를 통해 오류가 발생합니다.이 문제를 해결하려면 OpenShift Serverless 1.23으로 업그레이드한 후 클러스터에서

kafkabindings.webhook.kafka.sources.knative.dev MutatingWebhookConfiguration을 수동으로 삭제합니다.oc delete mutatingwebhookconfiguration kafkabindings.webhook.kafka.sources.knative.dev

$ oc delete mutatingwebhookconfiguration kafkabindings.webhook.kafka.sources.knative.devCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ingress에

net-istio를 사용하고security.dataPlane.mtls: true를 사용하여 SMCP를 통해 mTLS를 활성화하는 경우 Service Mesh는 OpenShift Serverless에 대한DomainMapping을 허용하지 않는*.local호스트에 대한DestinationRule을 배포합니다.이 문제를 해결하려면

security.dataPlane.mtls: true를 사용하는 대신PeerAuthentication을 배포하여 mTLS를 활성화합니다.

1.9. Red Hat OpenShift Serverless 1.23.0 릴리스 정보

OpenShift Serverless 1.23.0을 사용할 수 있습니다. 이 항목에는 OpenShift Container Platform의 OpenShift Serverless와 관련된 새로운 기능, 변경 사항, 알려진 문제가 포함되어 있습니다.

1.9.1. 새로운 기능

- OpenShift Serverless에서 Knative Serving 1.2를 사용합니다.

- OpenShift Serverless에서 Knative Eventing 1.2를 사용합니다.

- OpenShift Serverless에서 Kourier 1.2를 사용합니다.

-

OpenShift Serverless에서 Knative(

kn) CLI 1.2를 사용합니다. - OpenShift Serverless에서 Knative Kafka 1.2를 사용합니다.

-

kn funcCLI 플러그인에서func0.24를 사용합니다. -

Kafka 브로커와 함께

kafka.eventing.knative.dev/external.topic주석을 사용할 수 있습니다. 이 주석을 사용하면 브로커가 자체 내부 주제를 생성하는 대신 외부로 관리되는 기존 주제를 사용할 수 있습니다. -

kafka-ch-controller및kafka-webhookKafka 구성 요소가 더 이상 존재하지 않습니다. 이러한 구성 요소는kafka-webhook-eventing구성 요소로 교체되었습니다. - OpenShift Serverless Functions Technology Preview에서는 기본적으로 S2I(Source-to-Image)를 사용하여 컨테이너 이미지를 빌드합니다.

1.9.2. 확인된 문제

- Kafka 브로커, Kafka 소스 및 Kafka 싱크에 대해 연방 정보 처리 표준(FIPS) 모드가 비활성화되어 있습니다.

-

Kafka 브로커를 포함하는 네임스페이스를 삭제하는 경우 브로커의

auth.secret.ref.name보안이 브로커 전에 삭제되면 네임스페이스 종료자가 제거되지 않을 수 있습니다. 많은 Knative 서비스로 OpenShift Serverless를 실행하면 Knative 활성화기 Pod가 600MB의 기본 메모리 제한에 근접하게 실행될 수 있습니다. 메모리 사용량이 이 제한에 도달하면 이러한 Pod를 재시작할 수 있습니다. activator 배포에 대한 요청 및 제한은

KnativeServing사용자 정의 리소스를 수정하여 구성할 수 있습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

함수의 로컬 빌드 전략으로 Cloud Native Buildpacks 를 사용하는 경우

kn func는 podman을 자동으로 시작하거나 원격 데몬에 SSH 터널을 사용할 수 없습니다. 이러한 문제의 해결 방법은 함수를 배포하기 전에 로컬 개발 컴퓨터에서 Docker 또는 podman 데몬을 이미 실행하는 것입니다. - 현재 Quarkus 및 Golang 런타임의 경우 온프레미스 함수 빌드가 실패합니다. Node, Typescript, Python, Springboot 런타임에서 올바르게 작동합니다.

Ingress에

net-istio를 사용하고security.dataPlane.mtls: true를 사용하여 SMCP를 통해 mTLS를 활성화하는 경우 Service Mesh는 OpenShift Serverless에 대한DomainMapping을 허용하지 않는*.local호스트에 대한DestinationRule을 배포합니다.이 문제를 해결하려면

security.dataPlane.mtls: true를 사용하는 대신PeerAuthentication을 배포하여 mTLS를 활성화합니다.

1.10. Red Hat OpenShift Serverless 1.22.0 릴리스 정보

OpenShift Serverless 1.22.0을 사용할 수 있습니다. 이 항목에는 OpenShift Container Platform의 OpenShift Serverless와 관련된 새로운 기능, 변경 사항, 알려진 문제가 포함되어 있습니다.

1.10.1. 새로운 기능

- OpenShift Serverless에서 Knative Serving 1.1을 사용합니다.

- OpenShift Serverless에서 Knative Eventing 1.1을 사용합니다.

- OpenShift Serverless에서 Kourier 1.1을 사용합니다.

-

OpenShift Serverless에서 Knative(

kn) CLI 1.1을 사용합니다. - OpenShift Serverless에서 Knative Kafka 1.1을 사용합니다.

-

kn funcCLI 플러그인에서func0.23를 사용합니다. - Knative 서비스에 대한 init 컨테이너 지원이 기술 프리뷰로 제공됩니다.

- Knative 서비스에 대한 PVC(영구 볼륨 클레임) 지원이 기술 프리뷰로 제공됩니다.

-

knative-serving,knative-serving-ingress,knative-eventing및knative-kafka시스템 네임스페이스에는 기본적으로knative.openshift.io/part-of: "openshift-serverless"라벨이 있습니다. - Knative Eventing - Kafka Broker/Trigger 대시보드가 추가되어 Kafka 브로커를 시각화하고 웹 콘솔에서 메트릭을 트리거할 수 있습니다.

- Knative Eventing - KafkaSink 대시보드가 추가되어 웹 콘솔에서 KafkaSink 지표를 시각화할 수 있습니다.

- Knative Eventing - Broker/Trigger 대시보드가 Knative Eventing - 채널 기반 브로커/Trigger 라고도 합니다.

-

knative.openshift.io/part-of: "openshift-serverless"레이블에서knative.openshift.io/system-namespace레이블을 대체했습니다. -

Knative Serving YAML 구성 파일의 이름 지정 스타일은 camel case(

예: 이름)에서 하이픈 스타일(예:example-name)으로 변경되었습니다. 이 릴리스부터 Knative Serving YAML 구성 파일을 생성하거나 편집할 때 하이픈 스타일 표기법을 사용하십시오.

1.10.2. 확인된 문제

- Kafka 브로커, Kafka 소스 및 Kafka 싱크에 대해 연방 정보 처리 표준(FIPS) 모드가 비활성화되어 있습니다.

1.11. Red Hat OpenShift Serverless 1.21.0 릴리스 정보

OpenShift Serverless 1.21.0을 사용할 수 있습니다. 이 항목에는 OpenShift Container Platform의 OpenShift Serverless와 관련된 새로운 기능, 변경 사항, 알려진 문제가 포함되어 있습니다.

1.11.1. 새로운 기능

- OpenShift Serverless에서 Knative Serving 1.0 사용

- OpenShift Serverless에서 Knative Eventing 1.0을 사용합니다.

- OpenShift Serverless에서 Kourier 1.0을 사용합니다.

-

OpenShift Serverless에서 Knative(

kn) CLI 1.0을 사용합니다. - OpenShift Serverless에서 Knative Kafka 1.0을 사용합니다.

-

kn funcCLI 플러그인에서func0.21을 사용합니다. - Kafka 싱크를 기술 프리뷰로 사용할 수 있습니다.

-

Knative 오픈 소스 프로젝트는 kebab-cased 키를 일관되게 사용하기 위해 제공된 구성 키를 사용 중단하기 시작했습니다. 결과적으로 OpenShift Serverless 1.18.0 릴리스 노트에서 이전에 언급된

defaultExternalScheme키가 더 이상 사용되지 않으며default-external-scheme키로 대체됩니다. 키에 대한 사용 지침은 동일하게 유지됩니다.

1.11.2. 해결된 문제

-

OpenShift Serverless 1.20.0에는

kn event send를 사용하여 이벤트를 서비스로 보내는 데 영향을 미치는 이벤트 전달 문제가 있었습니다. 이제 이 문제가 해결되었습니다. -

OpenShift Serverless 1.20.0(

func0.20)에서http템플릿으로 생성된 TypeScript 함수가 클러스터에 배포되지 않았습니다. 이제 이 문제가 해결되었습니다. -

OpenShift Serverless 1.20.0(

func0.20)에서gcr.io레지스트리를 사용하여 함수를 배포하는 데 오류와 함께 실패했습니다. 이제 이 문제가 해결되었습니다. -

OpenShift Serverless 1.20.0(

func0.20)에서kn func create명령을 사용하여 Springboot 함수 프로젝트 디렉터리를 생성한 다음 kn func build 명령을 실행해도 오류 메시지와 함께kn func build명령이 실패했습니다. 이제 이 문제가 해결되었습니다. -

OpenShift Serverless 1.19.0(

func0.19)에서는 일부 런타임에서 podman을 사용하여 함수를 빌드할 수 없었습니다. 이제 이 문제가 해결되었습니다.

1.11.3. 확인된 문제

현재 도메인 매핑 컨트롤러는 현재 지원되지 않는 경로가 포함된 브로커의 URI를 처리할 수 없습니다.

즉,

DomainMappingCR(사용자 정의 리소스)을 사용하여 사용자 정의 도메인을 브로커에 매핑하려면 브로커의 수신 서비스로DomainMappingCR을 구성하고 브로커의 정확한 경로를 사용자 정의 도메인에 추가해야 합니다.DomainMappingCR의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow 브로커의 URI는 <

domain-name>/<broker-namespace>/<broker-name>입니다.

1.12. Red Hat OpenShift Serverless 1.20.0 릴리스 노트

OpenShift Serverless 1.20.0을 사용할 수 있습니다. 이 항목에는 OpenShift Container Platform의 OpenShift Serverless와 관련된 새로운 기능, 변경 사항, 알려진 문제가 포함되어 있습니다.

1.12.1. 새로운 기능

- OpenShift Serverless에서 Knative Serving 0.26을 사용합니다.

- OpenShift Serverless에서 Knative Eventing 0.26을 사용합니다.

- OpenShift Serverless에서 Kourier 0.26을 사용합니다.

-

OpenShift Serverless에서 Knative(

kn) CLI 0.26을 사용합니다. - OpenShift Serverless에서 Knative Kafka 0.26을 사용합니다.

-

kn funcCLI 플러그인에서func0.20을 사용합니다. Kafka 브로커를 기술 프리뷰로 사용할 수 있습니다.

중요현재 기술 프리뷰에 있는 Kafka 브로커는 FIPS에서 지원되지 않습니다.

-

kn 이벤트플러그인을 기술 프리뷰로 사용할 수 있습니다. -

kn service create명령의--min-scale및--max-scale플래그는 더 이상 사용되지 않습니다. 대신--scale-min및--scale-max플래그를 사용합니다.

1.12.2. 확인된 문제

OpenShift Serverless는 HTTPS를 사용하는 기본 주소로 Knative 서비스를 배포합니다. 클러스터 내부의 리소스로 이벤트를 보낼 때 발신자는 클러스터 CA(인증 기관)를 구성하지 않습니다. 이로 인해 클러스터가 전역적으로 허용되는 인증서를 사용하지 않는 한 이벤트 전달이 실패합니다.

예를 들어 공개적으로 액세스 가능한 주소로 이벤트 전달이 작동합니다.

kn event send --to-url https://ce-api.foo.example.com/

$ kn event send --to-url https://ce-api.foo.example.com/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 반면 서비스에서 사용자 정의 CA에서 발급한 HTTPS 인증서가 있는 공용 주소를 사용하는 경우 이 전달이 실패합니다.

kn event send --to Service:serving.knative.dev/v1:event-display

$ kn event send --to Service:serving.knative.dev/v1:event-displayCopy to Clipboard Copied! Toggle word wrap Toggle overflow 브로커 또는 채널과 같은 다른 주소 지정 가능 개체에 이벤트를 보내는 것은 이 문제의 영향을 받지 않으며 예상대로 작동합니다.

- Kafka 브로커는 현재 연방 정보 처리 표준(FIPS) 모드가 활성화된 클러스터에서 작동하지 않습니다.

kn func create명령을 사용하여 Springboot 함수 프로젝트 디렉터리를 생성하는 경우 다음 오류 메시지와 함께kn func build명령을 실행하면 실패합니다.[analyzer] no stack metadata found at path '' [analyzer] ERROR: failed to : set API for buildpack 'paketo-buildpacks/ca-certificates@3.0.2': buildpack API version '0.7' is incompatible with the lifecycle

[analyzer] no stack metadata found at path '' [analyzer] ERROR: failed to : set API for buildpack 'paketo-buildpacks/ca-certificates@3.0.2': buildpack API version '0.7' is incompatible with the lifecycleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 문제를 해결하려면 함수 구성 파일

func.yaml에서builder속성을gcr.io/paketo-buildpacks/builder:base로 변경할 수 있습니다.gcr.io레지스트리를 사용하여 함수를 배포하면 다음 오류 메시지와 함께 실패합니다.Error: failed to get credentials: failed to verify credentials: status code: 404

Error: failed to get credentials: failed to verify credentials: status code: 404Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 문제를 해결하려면

quay.io또는docker.io와 같은gcr.io와 다른 레지스트리를 사용하십시오.http템플릿으로 생성된 TypeScript 함수는 클러스터에 배포되지 않습니다.이 문제를 해결하려면

func.yaml파일에서 다음 섹션을 교체합니다.buildEnvs: []

buildEnvs: []Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 경우:

buildEnvs: - name: BP_NODE_RUN_SCRIPTS value: build

buildEnvs: - name: BP_NODE_RUN_SCRIPTS value: buildCopy to Clipboard Copied! Toggle word wrap Toggle overflow func버전 0.20에서 일부 런타임은 podman을 사용하여 함수를 빌드할 수 없습니다. 다음과 유사한 오류 메시지가 표시될 수 있습니다.ERROR: failed to image: error during connect: Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.40/info": EOF

ERROR: failed to image: error during connect: Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.40/info": EOFCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 문제에 대한 다음 해결방법이 있습니다.

서비스

ExecStart정의에--time=0을 추가하여 podman 서비스를 업데이트합니다.서비스 구성 예

ExecStart=/usr/bin/podman $LOGGING system service --time=0

ExecStart=/usr/bin/podman $LOGGING system service --time=0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 podman 서비스를 다시 시작합니다.

systemctl --user daemon-reload

$ systemctl --user daemon-reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl restart --user podman.socket

$ systemctl restart --user podman.socketCopy to Clipboard Copied! Toggle word wrap Toggle overflow

또는 TCP를 사용하여 podman API를 노출할 수도 있습니다.

podman system service --time=0 tcp:127.0.0.1:5534 & export DOCKER_HOST=tcp://127.0.0.1:5534

$ podman system service --time=0 tcp:127.0.0.1:5534 & export DOCKER_HOST=tcp://127.0.0.1:5534Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.13. Red Hat OpenShift Serverless 1.19.0 릴리스 노트

OpenShift Serverless 1.19.0을 사용할 수 있습니다. 이 항목에는 OpenShift Container Platform의 OpenShift Serverless와 관련된 새로운 기능, 변경 사항, 알려진 문제가 포함되어 있습니다.

1.13.1. 새로운 기능

- OpenShift Serverless에서 Knative Serving 0.25를 사용합니다.

- OpenShift Serverless에서 Knative Eventing 0.25를 사용합니다.

- OpenShift Serverless에서 Kourier 0.25를 사용합니다.

-

OpenShift Serverless에서 Knative(

kn) CLI 0.25를 사용합니다. - OpenShift Serverless에서 Knative Kafka 0.25를 사용합니다.

-

kn funcCLI 플러그인에서func0.19를 사용합니다. -

KafkaBindingAPI는 OpenShift Serverless 1.19.0에서 더 이상 사용되지 않으며 향후 릴리스에서 제거됩니다. - 이제 HTTPS 리디렉션이 지원되며 클러스터 또는 각 Knative 서비스에 대해 전역적으로 구성할 수 있습니다.

1.13.2. 해결된 문제

- 이전 릴리스에서 Kafka 채널 디스패처는 응답하기 전에 로컬 커밋이 성공할 때만 대기했습니다. 이로 인해 Apache Kafka 노드 실패 시 이벤트가 손실되었을 수 있습니다. 이제 Kafka 채널 디스패처가 응답하기 전에 모든 비동기 복제본이 커밋될 때까지 대기합니다.

1.13.3. 확인된 문제

func버전 0.19에서는 podman을 사용하여 일부 런타임에서 함수를 빌드할 수 없습니다. 다음과 유사한 오류 메시지가 표시될 수 있습니다.ERROR: failed to image: error during connect: Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.40/info": EOF

ERROR: failed to image: error during connect: Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.40/info": EOFCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 문제에 대한 다음 해결방법이 있습니다.

서비스

ExecStart정의에--time=0을 추가하여 podman 서비스를 업데이트합니다.서비스 구성 예

ExecStart=/usr/bin/podman $LOGGING system service --time=0

ExecStart=/usr/bin/podman $LOGGING system service --time=0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 podman 서비스를 다시 시작합니다.

systemctl --user daemon-reload

$ systemctl --user daemon-reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl restart --user podman.socket

$ systemctl restart --user podman.socketCopy to Clipboard Copied! Toggle word wrap Toggle overflow

또는 TCP를 사용하여 podman API를 노출할 수도 있습니다.

podman system service --time=0 tcp:127.0.0.1:5534 & export DOCKER_HOST=tcp://127.0.0.1:5534

$ podman system service --time=0 tcp:127.0.0.1:5534 & export DOCKER_HOST=tcp://127.0.0.1:5534Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.14. Red Hat OpenShift Serverless 1.18.0 릴리스 정보

OpenShift Serverless 1.18.0을 사용할 수 있습니다. 이 항목에는 OpenShift Container Platform의 OpenShift Serverless와 관련된 새로운 기능, 변경 사항, 알려진 문제가 포함되어 있습니다.

1.14.1. 새로운 기능

- OpenShift Serverless에서 Knative Serving 0.24.0을 사용합니다.

- OpenShift Serverless에서 Knative Eventing 0.24.0을 사용합니다.

- OpenShift Serverless에서 Kourier 0.24.0을 사용합니다.

-

OpenShift Serverless에서 Knative(

kn) CLI 0.24.0을 사용합니다. - OpenShift Serverless에서 Knative Kafka 0.24.7을 사용합니다.

-

kn funcCLI 플러그인에서func0.18.0을 사용합니다. 향후 OpenShift Serverless 1.19.0 릴리스에서는 보안을 강화하기 위해 외부 경로의 URL 체계가 기본적으로 HTTPS로 설정됩니다.

이 변경 사항을 워크로드에 적용하지 않으려면

KnativeServing사용자 정의 리소스(CR)에 다음 YAML을 추가하여 1.19.0로 업그레이드하기 전에 기본 설정을 덮어쓸 수 있습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 1.18.0에 변경 사항을 적용하려면 다음 YAML을 추가합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 향후 OpenShift Serverless 1.19.0 릴리스에서 Kourier 게이트웨이가 노출되는 기본 서비스 유형은

ClusterIP이며LoadBalancer가 아닙니다.이 변경 사항을 워크로드에 적용하지 않으려면

KnativeServing사용자 정의 리소스(CR)에 다음 YAML을 추가하여 1.19.0로 업그레이드하기 전에 기본 설정을 덮어쓸 수 있습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

OpenShift Serverless에서

emptyDir볼륨을 사용할 수 있습니다. 자세한 내용은 Knative Serving에 대한 OpenShift Serverless 문서를 참조하십시오. -

kn func를 사용하여 함수를 생성할 때 rust 템플릿을 사용할 수 있습니다.

1.14.2. 해결된 문제

- Camel-K의 이전 1.4 버전은 OpenShift Serverless 1.17.0과 호환되지 않았습니다. Camel-K의 문제가 해결되었으며 Camel-K 버전 1.4.1은 OpenShift Serverless 1.17.0과 함께 사용할 수 있습니다.

이전 버전에서는 Kafka 채널 또는 새 Kafka 소스에 대한 새 서브스크립션을 생성한 경우 새로 생성된 서브스크립션 또는 싱크에서 준비 상태를 보고한 후 Kafka 데이터 플레인에서 메시지를 디스패치할 수 있었습니다.

그 결과 데이터 플레인에서 준비 상태를 보고하지 않은 시간 동안 전송된 메시지가 구독자 또는 싱크로 전달되지 않았을 수 있었습니다.

OpenShift Serverless 1.18.0에서는 문제가 해결되어 초기 메시지가 더 이상 손실되지 않습니다. 이 문제에 대한 자세한 내용은 지식베이스 문서 #6343981 을 참조하십시오.

1.14.3. 확인된 문제

이전 버전의 Knative

knCLI에서는 이전 버전의 Knative Serving 및 Knative Eventing API를 사용할 수 있습니다. 예를 들어knCLI의 버전 0.23.2에서는v1alpha1API 버전을 사용합니다.반면 최신 OpenShift Serverless 릴리스는 더 이상 이전 API 버전을 지원하지 않을 수 있습니다. 예를 들어 OpenShift Serverless 1.18.0은

kafkasources.sources.knative.devAPI의 버전v1alpha1을 지원하지 않습니다.결과적으로 이전 버전의 Knative

knCLI를 최신 OpenShift Serverless와 함께 사용하면kn이 오래된 API를 찾을 수 없기 때문에 오류가 발생할 수 있습니다. 예를 들어knCLI의 버전 0.23.2는 OpenShift Serverless 1.18.0에서 작동하지 않습니다.문제를 방지하려면 OpenShift Serverless 릴리스에 사용 가능한 최신

knCLI 버전을 사용하십시오. OpenShift Serverless 1.18.0의 경우 KnativeknCLI 0.24.0을 사용합니다.

2장. Serverless 정보

2.1. OpenShift Serverless 개요

OpenShift Serverless에서는 개발자가 OpenShift Container Platform에서 서버리스 애플리케이션을 생성하고 배포할 수 있는 Kubernetes 기본 구성 요소를 제공합니다. OpenShift Serverless는 엔터프라이즈급 서버리스 플랫폼을 활성화하여 하이브리드 및 멀티 클라우드 환경에 대한 이식성 및 일관성을 제공하는 오픈 소스 Knative 프로젝트를 기반으로 합니다.

OpenShift Serverless는 OpenShift Container Platform과 다른 간격으로 릴리스되기 때문에 OpenShift Serverless 문서는 마이너 버전의 제품 버전에 대한 별도의 문서 세트를 유지 관리하지 않습니다. 현재 문서 세트는 특정 주제 또는 특정 기능에 대해 버전별 제한이 호출되지 않는 한 현재 지원되는 모든 OpenShift Serverless 버전에 적용됩니다.

OpenShift Serverless 라이프 사이클 및 지원되는 플랫폼에 대한 자세한 내용은 플랫폼 라이프 사이클 정책을 참조하십시오.

2.2. Knative Serving

Knative Serving은 클라우드 네이티브 애플리케이션을 생성, 배포, 관리하려는 개발자를 지원합니다. OpenShift Container Platform 클러스터에서 서버리스 워크로드의 동작을 정의하고 제어하는 Kubernetes CRD(사용자 정의 리소스 정의)로 오브젝트 세트를 제공합니다.

개발자는 이러한 CRD를 사용하여 복잡한 사용 사례를 다룰 때 구성 요소로 사용할 수 있는 CR(사용자 정의 리소스) 인스턴스를 생성합니다. 예를 들면 다음과 같습니다.

- 신속한 서버리스 컨테이너 배포.

- Pod 자동 스케일링.

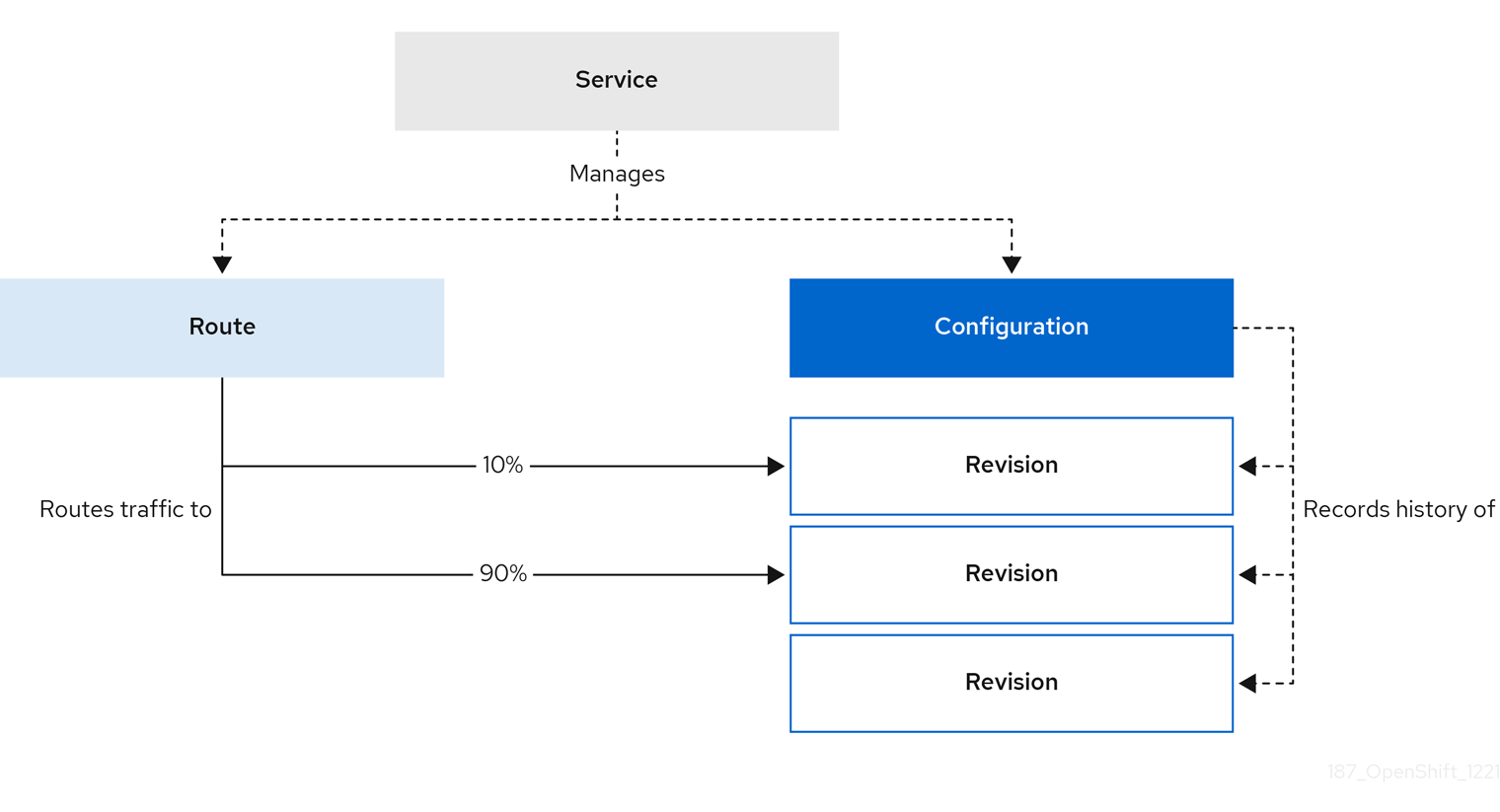

2.2.1. Knative Serving 리소스

- 서비스

-

service.serving.knative.devCRD를 사용하면 워크로드의 라이프사이클을 자동으로 관리하여 네트워크를 통해 애플리케이션을 배포하고 연결할 수 있습니다. 이 CRD는 사용자 생성 서비스 또는 사용자 정의 리소스가 변경될 때마다 경로, 구성, 새 버전을 생성합니다. Knative의 개발자 상호 작용은 대부분 서비스 수정을 통해 수행됩니다. - 버전

-

revision.serving.knative.devCRD는 워크로드에 수행된 각 수정의 코드 및 구성에 대한 시점 스냅샷입니다. 버전은 변경할 수 없는 오브젝트이며 필요한 기간에 유지할 수 있습니다. - Route

-

route.serving.knative.devCRD는 네트워크 끝점을 하나 이상의 버전에 매핑합니다. 부분 트래픽 및 이름이 지정된 경로를 포함하여 다양한 방법으로 트래픽을 관리할 수 있습니다. - 설정

-

configuration.serving.knative.devCRD는 배포에 필요한 상태를 유지 관리합니다. 코드와 구성을 명확하게 분리합니다. 구성을 수정하면 새 버전이 생성됩니다.

2.3. Knative Eventing

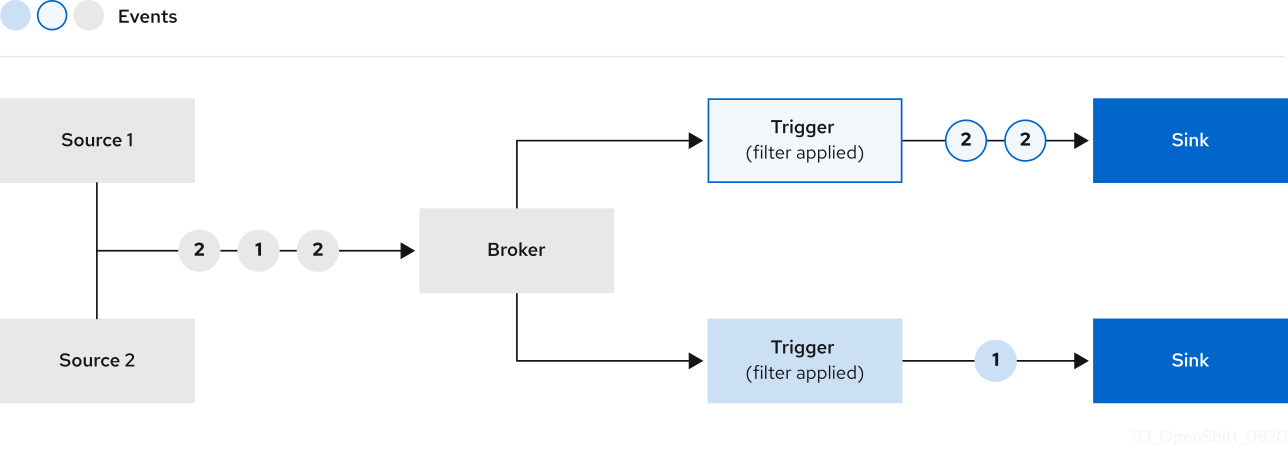

OpenShift Container Platform에서 Knative Eventing을 사용하면 개발자가 서버리스 애플리케이션에 이벤트 중심 아키텍처를 사용할 수 있습니다. 이벤트 중심 아키텍처는 이벤트 생산자와 이벤트 소비자 간 분리된 관계에 대한 개념을 기반으로 합니다.

이벤트 프로듀서는 이벤트를 생성하고 이벤트 싱크 또는 소비자를 통해 이벤트를 수신합니다. Knative Eventing은 표준 HTTP POST 요청을 사용하여 이벤트 프로듀서와 싱크 사이에서 이벤트를 전송하고 수신합니다. 이러한 이벤트는 이벤트를 모든 프로그래밍 언어로 생성, 구문 분석, 전송, 수신할 수 있도록 CloudEvents 사양을 준수합니다.

Knative Eventing에서는 다음 유스 케이스를 지원합니다.

- 소비자를 생성하지 않고 이벤트 게시

- 이벤트를 HTTP POST에 브로커로 보내고 바인딩을 사용하여 이벤트를 생성하는 애플리케이션에서 대상 구성을 분리할 수 있습니다.

- 게시자를 생성하지 않고 이벤트 사용

- 트리거를 사용하면 이벤트 특성을 기반으로 브로커의 이벤트를 사용할 수 있습니다. 애플리케이션은 이벤트를 HTTP POST로 수신합니다.

Knative Eventing에서는 다양한 싱크 유형으로 전달할 수 있도록 다음과 같이 여러 Kubernetes 리소스에서 구현할 수 있는 일반 인터페이스를 정의합니다.

- 주소 지정 가능 리소스

-

HTTP를 통해 전달되는 이벤트를 이벤트의

status.address.url필드에 정의된 주소로 수신 및 승인할 수 있습니다. KubernetesService리소스도 주소 지정 가능 인터페이스의 조건을 충족합니다. - 호출 가능한 리소스

-

HTTP를 통해 전달되는 이벤트를 수신하고 변환하여 HTTP 응답 페이로드에서

0또는1개의 새 이벤트를 반환합니다. 반환된 이벤트는 외부 이벤트 소스의 이벤트를 처리하는 것과 동일한 방식으로 추가로 처리할 수 있습니다.

2.3.1. Knative Kafka 사용

Knative Kafka는 OpenShift Serverless에서 지원되는 Apache Kafka 메시지 스트리밍 플랫폼을 사용할 수 있는 통합 옵션을 제공합니다. Kafka는 이벤트 소스, 채널, 브로커 및 이벤트 싱크 기능에 대한 옵션을 제공합니다.

Knative Kafka는 현재 IBM Z 및 IBM Power에서 지원되지 않습니다.

Knative Kafka는 다음과 같은 추가 옵션을 제공합니다.

- Kafka 소스

- Kafka 채널

- Kafka 브로커

- Kafka 싱크

2.4. OpenShift Serverless Functions 정보

OpenShift Serverless Functions를 사용하면 개발자가 상태 비저장 이벤트 중심 함수를 OpenShift Container Platform에서 Knative 서비스로 생성하고 배포할 수 있습니다. kn func CLI는 Knative kn CLI의 플러그인으로 제공됩니다. kn func CLI를 사용하여 컨테이너 이미지를 클러스터에서 Knative 서비스로 생성, 빌드, 배포할 수 있습니다.

2.4.1. 포함된 런타임

OpenShift Serverless Functions는 다음 런타임에 대한 기본 기능을 생성하는 데 사용할 수 있는 템플릿을 제공합니다.

2.4.2. 다음 단계

3장. Serverless 설치

3.1. OpenShift Serverless 설치 준비

OpenShift Serverless를 설치하기 전에 지원되는 구성 및 사전 요구 사항에 대한 다음 정보를 읽으십시오.

- OpenShift Serverless는 제한된 네트워크 환경에서 설치할 수 있습니다.

- OpenShift Serverless는 현재 단일 클러스터의 다중 테넌트 구성에서 사용할 수 없습니다.

3.1.1. 지원되는 구성

OpenShift Serverless에 지원되는 일련의 기능, 구성, 통합과 현재 버전 및 이전 버전은 지원되는 구성 페이지에서 확인할 수 있습니다.

3.1.2. 확장 및 성능

OpenShift Serverless는 3개의 기본 노드와 3개의 작업자 노드 구성으로 테스트되었으며 각각 64개의 CPU, 457GB의 메모리 및 394GB의 스토리지가 있습니다.

이 구성을 사용하여 생성할 수 있는 최대 Knative 서비스 수는 3000개입니다. 이는 Knative 1개 서비스에서 3개의 Kubernetes 서비스를 생성하기 때문에 OpenShift Container Platform Kubernetes 서비스 제한 10,000 에 해당합니다.

응답 시간이 최대 8초이고, 간단한 Quarkus 애플리케이션의 경우 99.9번째 백분위 시간이 4.5초인 평균 응답 시간이 평균 3.4초였습니다. 이러한 시간은 애플리케이션 및 애플리케이션 런타임에 따라 다를 수 있습니다.

3.1.3. 클러스터 크기 요구사항 정의

OpenShift Serverless를 설치하고 사용하려면 OpenShift Container Platform 클러스터의 크기를 올바르게 조정해야 합니다.

다음 요구 사항은 OpenShift Container Platform 클러스터의 작업자 머신 풀에만 관련이 있습니다. 컨트롤 플레인 노드는 일반 스케줄링에 사용되지 않으며 요구 사항에서 생략됩니다.

OpenShift Serverless를 사용하기 위한 최소 요구 사항은 CPU 10개와 40GB 메모리가 있는 클러스터입니다. 기본적으로 각 Pod는 ~400m의 CPU를 요청하므로 최소 요구 사항은 이 값을 기반으로 합니다.

OpenShift Serverless를 실행하는 총 크기 요구 사항은 설치된 구성 요소와 배포된 애플리케이션에 따라 달라질 수 있으며 배포에 따라 다를 수 있습니다.

3.1.4. 컴퓨팅 머신 세트를 사용하여 클러스터 스케일링

OpenShift Container Platform MachineSet API를 사용하여 클러스터를 원하는 크기로 수동으로 확장할 수 있습니다. 최소 요구 사항은 일반적으로 기본 컴퓨팅 시스템 세트 중 하나를 두 개의 추가 머신으로 확장해야 함을 의미합니다. 컴퓨팅 머신 세트 수동 스케일링을 참조하십시오.

3.1.4.1. 고급 사용 사례에 대한 추가 요구 사항

OpenShift Container Platform에서 로깅 또는 미터링과 같은 고급 사용 사례의 경우 더 많은 리소스를 배포해야 합니다. 이러한 사용 사례에 권장되는 요구 사항은 CPU 24개 및 메모리 96GB입니다.

클러스터에 HA(고가용성)를 활성화하면 Knative Serving 컨트롤 플레인을 복제할 때마다 0.5 ~ 1.5코어 및 200MB ~ 2GB의 메모리가 필요합니다. HA는 기본적으로 일부 Knative Serving 구성 요소에 사용됩니다. "고가용성 복제본 구성"에 대한 문서에 따라 HA를 비활성화할 수 있습니다.

3.2. OpenShift Serverless Operator 설치

OpenShift Serverless Operator를 설치하면 OpenShift Container Platform 클러스터에 Knative Serving, Knative Eventing, Knative Kafka를 설치하고 사용할 수 있습니다. OpenShift Serverless Operator는 클러스터의 Knative CRD(사용자 정의 리소스 정의)를 관리하고 각 구성 요소의 개별 구성 맵을 직접 수정하지 않고도 구성할 수 있습니다.

3.2.1. 웹 콘솔에서 OpenShift Serverless Operator 설치

OpenShift Container Platform 웹 콘솔을 사용하여 OperatorHub에서 OpenShift Serverless Operator를 설치할 수 있습니다. 이 Operator를 설치하면 Knative 구성 요소를 설치하고 사용할 수 있습니다.

사전 요구 사항

- 클러스터 관리자 액세스 권한이 있는 OpenShift Container Platform 계정에 액세스할 수 있습니다.

- OpenShift Container Platform 웹 콘솔에 로그인했습니다.

절차

- OpenShift Container Platform 웹 콘솔에서 Operator → OperatorHub 페이지로 이동합니다.

- 스크롤하거나 키워드로 필터링 상자에 키워드 서버리스를 입력하여 OpenShift Serverless Operator를 찾습니다.

- Operator에 대한 정보를 검토하고 설치를 클릭합니다.

Operator 설치 페이지에서 다음을 수행합니다.

-

설치 모드는 클러스터의 모든 네임스페이스(기본값)입니다. 이 모드에서는 클러스터의 모든 네임스페이스를 감시하고 사용할 수 있도록 기본

openshift-serverless네임스페이스에 Operator를 설치합니다. -

설치된 네임스페이스 는

openshift-serverless입니다. - stable 채널을 업데이트 채널로 선택합니다. stable 채널을 사용하면 안정적인 최신 릴리스의 OpenShift Pipelines Operator를 설치할 수 있습니다.

- 자동 또는 수동 승인 전략을 선택합니다.

-

설치 모드는 클러스터의 모든 네임스페이스(기본값)입니다. 이 모드에서는 클러스터의 모든 네임스페이스를 감시하고 사용할 수 있도록 기본

- 이 OpenShift Container Platform 클러스터에서 선택한 네임스페이스에서 Operator를 사용할 수 있도록 하려면 설치를 클릭합니다.

카탈로그 → Operator 관리 페이지에서 OpenShift Serverless Operator 서브스크립션 설치 및 업그레이드 진행 상황을 모니터링할 수 있습니다.

- 수동 승인 전략을 선택한 경우 설치 계획을 검토하고 승인할 때까지 서브스크립션의 업그레이드 상태가 업그레이드 중으로 유지됩니다. 설치 계획 페이지에서 승인한 후 subscription 업그레이드 상태가 최신으로 이동합니다.

- 자동 승인 전략을 선택한 경우 업그레이드 상태가 개입 없이 최신 상태로 확인되어야 합니다.

검증

서브스크립션의 업그레이드 상태가 최신인 경우 카탈로그 → 설치된 Operator를 선택하여 OpenShift Serverless Operator가 표시되고 관련 네임스페이스에서 상태가 최종적으로 InstallSucceeded로 표시되는지 확인합니다.

그러지 않은 경우 다음을 수행합니다.

- 카탈로그 → Operator 관리 페이지로 전환한 후 Operator 서브스크립션 및 설치 계획 탭의 상태에 장애나 오류가 있는지 검사합니다.

-

워크로드 → Pod 페이지의

openshift-serverless프로젝트에서 문제를 보고하는 Pod의 로그를 확인하여 추가로 문제를 해결합니다.

OpenShift Serverless에서 Red Hat OpenShift distributed tracing을 사용하려면 Knative Serving 또는 Knative Eventing을 설치하기 전에 Red Hat OpenShift distributed tracing을 설치하고 구성해야 합니다.

3.2.2. CLI에서 OpenShift Serverless Operator 설치

CLI를 사용하여 OperatorHub에서 OpenShift Serverless Operator를 설치할 수 있습니다. 이 Operator를 설치하면 Knative 구성 요소를 설치하고 사용할 수 있습니다.

사전 요구 사항

- 클러스터 관리자 액세스 권한이 있는 OpenShift Container Platform 계정에 액세스할 수 있습니다.

- 클러스터에 Marketplace 기능이 활성화되었거나 Red Hat Operator 카탈로그 소스가 수동으로 구성되어 있습니다.

- OpenShift Container Platform 클러스터에 로그인했습니다.

절차

Namespace,OperatorGroup,Subscription오브젝트가 포함된 YAML 파일을 생성하여 OpenShift Serverless Operator에 네임스페이스를 서브스크립션합니다. 예를 들어 다음 콘텐츠를 사용하여서버리스-subscription.yaml파일을 생성합니다.서브스크립션 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Operator의 채널 이름입니다.

stable채널을 사용하면 OpenShift Serverless Operator의 최신 안정적인 버전을 설치할 수 있습니다. - 2

- 등록할 Operator의 이름입니다. OpenShift Serverless Operator의 경우 항상

서버리스 운영자입니다. - 3

- Operator를 제공하는 CatalogSource의 이름입니다. 기본 OperatorHub 카탈로그 소스에

redhat-operators를 사용합니다. - 4

- CatalogSource의 네임스페이스입니다. 기본 OperatorHub 카탈로그 소스에는

openshift-marketplace를 사용합니다.

Subscription오브젝트를 생성합니다.oc apply -f serverless-subscription.yaml

$ oc apply -f serverless-subscription.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

CSV(클러스터 서비스 버전)가 Succeeded 단계에 도달했는지 확인합니다.

명령 예

$ oc get csv

$ oc get csv출력 예

NAME DISPLAY VERSION REPLACES PHASE serverless-operator.v1.25.0 Red Hat OpenShift Serverless 1.25.0 serverless-operator.v1.24.0 Succeeded

NAME DISPLAY VERSION REPLACES PHASE

serverless-operator.v1.25.0 Red Hat OpenShift Serverless 1.25.0 serverless-operator.v1.24.0 SucceededOpenShift Serverless에서 Red Hat OpenShift distributed tracing을 사용하려면 Knative Serving 또는 Knative Eventing을 설치하기 전에 Red Hat OpenShift distributed tracing을 설치하고 구성해야 합니다.

3.2.3. 글로벌 구성

OpenShift Serverless Operator는 KnativeServing 및 KnativeEventing 사용자 정의 리소스에서 시스템 구성 맵에 값을 부여하는 등 Knative 설치의 글로벌 구성을 관리합니다. Operator에서 수동으로 적용되는 구성 맵에 대한 업데이트는 모두 덮어씁니다. 그러나 Knative 사용자 정의 리소스를 수정하면 이러한 구성 맵의 값을 설정할 수 있습니다.

Knative에는 이름이 config- 인 여러 구성 맵이 있습니다. 모든 Knative 구성 맵은 적용되는 사용자 정의 리소스와 동일한 네임스페이스에 생성됩니다. 예를 들어 knative-serving 네임스페이스에 KnativeServing 사용자 정의 리소스가 생성되는 경우 이 네임스페이스에 모든 Knative Serving 구성 맵도 생성됩니다.

Knative 사용자 정의 리소스의 spec.config 에는 구성 맵 데이터에 사용되는 값과 함께 config-<name >이라는 각 구성 맵에 대해 하나의 <name> 항목이 있습니다.

3.2.5. 다음 단계

- OpenShift Serverless Operator를 설치한 후 Knative Serving을 설치하거나 Knative Eventing을 설치할 수 있습니다.

3.3. Knative CLI 설치

Knative(kn) CLI에는 자체 로그인 메커니즘이 없습니다. 클러스터에 로그인하려면 OpenShift CLI(oc)를 설치하고 oc login 명령을 사용해야 합니다. CLI의 설치 옵션은 운영 체제에 따라 다를 수 있습니다.

운영 체제에 대한 OpenShift CLI(oc)를 설치하고 oc 로 로그인하는 방법에 대한 자세한 내용은 OpenShift CLI 시작하기 설명서를 참조하십시오.

OpenShift Serverless는 Knative(kn) CLI를 사용하여 설치할 수 없습니다. 클러스터 관리자는 OpenShift Serverless Operator 설치 설명서에 설명된 대로 OpenShift Serverless Operator 를 설치하고 Knative 구성 요소를 설정해야 합니다.

최신 OpenShift Serverless 릴리스와 함께 이전 버전의 Knative(kn) CLI를 사용하려는 경우 API를 찾을 수 없으며 오류가 발생합니다.

예를 들어 Knative Serving 및 Knative Eventing API의 1.3 버전을 사용하는 1.24.0 OpenShift Serverless 릴리스에서 버전 1.2를 사용하는 Knative(kn) CLI의 1.23.0 릴리스를 사용하는 경우 이전 1.2 API 버전을 계속 찾기 때문에 CLI가 작동하지 않습니다.

문제를 방지하려면 OpenShift Serverless 릴리스에 최신 Knative(kn) CLI 버전을 사용하고 있는지 확인합니다.

3.3.1. OpenShift Container Platform 웹 콘솔을 통한 Knative CLI 설치

OpenShift Container Platform 웹 콘솔을 사용하면 간소화되고 직관적인 사용자 인터페이스를 제공하여 Knative(kn) CLI를 설치할 수 있습니다. OpenShift Serverless Operator가 설치되면 OpenShift Container Platform 웹 콘솔의 명령줄 툴 페이지에 Linux (amd64, s390x, ppc64le), macOS 또는 Windows에 대한 Knative (kn) CLI를 다운로드할 수 있는 링크가 표시됩니다.

사전 요구 사항

- OpenShift Container Platform 웹 콘솔에 로그인했습니다.

OpenShift Serverless Operator 및 Knative Serving이 OpenShift Container Platform 클러스터에 설치되어 있습니다.

중요libc를 사용할 수 없는 경우 CLI 명령을 실행할 때 다음과 같은 오류가 표시될 수 있습니다.

kn: No such file or directory

$ kn: No such file or directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

이 절차에 대한 확인 단계를 사용하려면 OpenShift (

oc) CLI를 설치해야 합니다.

절차

-

명령줄 툴 페이지에서 Knative(

kn) CLI를 다운로드합니다. 웹 콘솔의 오른쪽 상단에 있는 아이콘을 클릭하고 목록에서 명령줄 툴을 선택하여 명령줄 툴에 액세스할 수 있습니다.

아이콘을 클릭하고 목록에서 명령줄 툴을 선택하여 명령줄 툴에 액세스할 수 있습니다.

아카이브의 압축을 풉니다.

tar -xf <file>

$ tar -xf <file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

kn바이너리를PATH의 디렉터리로 이동합니다. PATH를 확인하려면 다음을 실행합니다.echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

다음 명령을 실행하여 올바른 Knative CLI 리소스 및 경로가 생성되었는지 확인합니다.

oc get ConsoleCLIDownload

$ oc get ConsoleCLIDownloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME DISPLAY NAME AGE kn kn - OpenShift Serverless Command Line Interface (CLI) 2022-09-20T08:41:18Z oc-cli-downloads oc - OpenShift Command Line Interface (CLI) 2022-09-20T08:00:20Z

NAME DISPLAY NAME AGE kn kn - OpenShift Serverless Command Line Interface (CLI) 2022-09-20T08:41:18Z oc-cli-downloads oc - OpenShift Command Line Interface (CLI) 2022-09-20T08:00:20ZCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc get route -n openshift-serverless

$ oc get route -n openshift-serverlessCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD kn kn-openshift-serverless.apps.example.com knative-openshift-metrics-3 http-cli edge/Redirect None

NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD kn kn-openshift-serverless.apps.example.com knative-openshift-metrics-3 http-cli edge/Redirect NoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.2. RPM 패키지 관리자를 사용하여 Linux용 Knative CLI 설치

RHEL(Red Hat Enterprise Linux)의 경우 yum 또는 dnf 와 같은 패키지 관리자를 사용하여 Knative(kn) CLI를 RPM으로 설치할 수 있습니다. 이를 통해 Knative CLI 버전을 시스템에서 자동으로 관리할 수 있습니다. 예를 들어 dnf 업그레이드와 같은 명령을 사용하면 새 버전을 사용할 수 있는 경우 kn 을 포함한 모든 패키지가 업그레이드됩니다.

사전 요구 사항

- Red Hat 계정에 활성 OpenShift Container Platform 서브스크립션이 있어야 합니다.

절차

Red Hat Subscription Manager에 등록합니다.

subscription-manager register

# subscription-manager registerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 최신 서브스크립션 데이터를 가져옵니다.

subscription-manager refresh

# subscription-manager refreshCopy to Clipboard Copied! Toggle word wrap Toggle overflow 등록된 시스템에 서브스크립션을 연결합니다.

subscription-manager attach --pool=<pool_id>

# subscription-manager attach --pool=<pool_id>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 활성 OpenShift Container Platform 서브스크립션의 풀 ID

Knative(

kn) CLI에 필요한 리포지토리를 활성화합니다.Linux (x86_64, amd64)

subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-x86_64-rpms"

# subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-x86_64-rpms"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Linux on IBM Z 및 LinuxONE(s390x)

subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-s390x-rpms"

# subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-s390x-rpms"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Linux on IBM Power(ppc64le)

subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-ppc64le-rpms"

# subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-ppc64le-rpms"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

패키지 관리자를 사용하여 Knative(

kn) CLI를 RPM으로 설치합니다.yum명령 예yum install openshift-serverless-clients

# yum install openshift-serverless-clientsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.3. Linux의 Knative CLI 설치

RPM 또는 다른 패키지 관리자가 설치되어 있지 않은 Linux 배포를 사용하는 경우 Knative(kn) CLI를 바이너리 파일로 설치할 수 있습니다. 이렇게 하려면 tar.gz 아카이브를 다운로드하여 압축 해제하고 PATH 의 디렉터리에 바이너리를 추가해야 합니다.

사전 요구 사항

RHEL 또는 Fedora를 사용하지 않는 경우 libc 가 라이브러리 경로의 디렉터리에 설치되어 있는지 확인합니다.

중요libc를 사용할 수 없는 경우 CLI 명령을 실행할 때 다음과 같은 오류가 표시될 수 있습니다.

kn: No such file or directory

$ kn: No such file or directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow

절차

관련 Knative(

kn) CLItar.gz아카이브를 다운로드합니다.Serverless 클라이언트 다운로드 미러에서 해당 버전의 해당 디렉터리로 이동하여

kn버전을 다운로드할 수도 있습니다.아카이브의 압축을 풉니다.

tar -xf <filename>

$ tar -xf <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

kn바이너리를PATH의 디렉터리로 이동합니다. PATH를 확인하려면 다음을 실행합니다.echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.4. macOS용 Knative CLI 설치

macOS를 사용하는 경우 Knative(kn) CLI를 바이너리 파일로 설치할 수 있습니다. 이렇게 하려면 tar.gz 아카이브를 다운로드하여 압축 해제하고 PATH 의 디렉터리에 바이너리를 추가해야 합니다.

절차

Knative(

kn) CLItar.gz아카이브를 다운로드합니다.Serverless 클라이언트 다운로드 미러에서 해당 버전의 해당 디렉터리로 이동하여

kn버전을 다운로드할 수도 있습니다.- 아카이브의 압축을 풀고 압축을 풉니다.

-

kn바이너리를PATH의 디렉터리로 이동합니다. PATH를 확인하려면 터미널 창을 열고 다음을 실행합니다.echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.5. Windows용 Knative CLI 설치

Windows를 사용하는 경우 Knative(kn) CLI를 바이너리 파일로 설치할 수 있습니다. 이렇게 하려면 ZIP 아카이브를 다운로드하여 압축 해제하고 PATH 의 디렉터리에 바이너리를 추가해야 합니다.

절차

Knative(

kn) CLI ZIP 아카이브를 다운로드합니다.Serverless 클라이언트 다운로드 미러에서 해당 버전의 해당 디렉터리로 이동하여

kn버전을 다운로드할 수도 있습니다.- ZIP 프로그램으로 아카이브의 압축을 풉니다.

-

kn바이너리를PATH의 디렉터리로 이동합니다. PATH를 확인하려면 명령 프롬프트를 열고 다음 명령을 실행합니다.path

C:\> pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4. Knative Serving 설치

Knative Serving을 설치하면 클러스터에서 Knative 서비스 및 함수를 생성할 수 있습니다. 또한 애플리케이션의 자동 스케일링 및 네트워킹 옵션과 같은 추가 기능을 사용할 수 있습니다.

OpenShift Serverless Operator를 설치한 후 기본 설정을 사용하여 Knative Serving을 설치하거나 KnativeServing 사용자 정의 리소스(CR)에서 고급 설정을 구성할 수 있습니다. KnativeServing CR의 구성 옵션에 대한 자세한 내용은 글로벌 구성을 참조하십시오.

OpenShift Serverless에서 Red Hat OpenShift distributed tracing을 사용하려면 Knative Serving을 설치하기 전에 Red Hat OpenShift distributed tracing을 설치하고 구성해야 합니다.

3.4.1. 웹 콘솔을 사용하여 Knative Serving 설치

OpenShift Serverless Operator를 설치한 후 OpenShift Container Platform 웹 콘솔을 사용하여 Knative Serving을 설치합니다. 기본 설정을 사용하여 Knative Serving을 설치하거나 KnativeServing 사용자 정의 리소스(CR)에서 고급 설정을 구성할 수 있습니다.

사전 요구 사항

- 클러스터 관리자 액세스 권한이 있는 OpenShift Container Platform 계정에 액세스할 수 있습니다.

- OpenShift Container Platform 웹 콘솔에 로그인했습니다.

- OpenShift Serverless Operator를 설치했습니다.

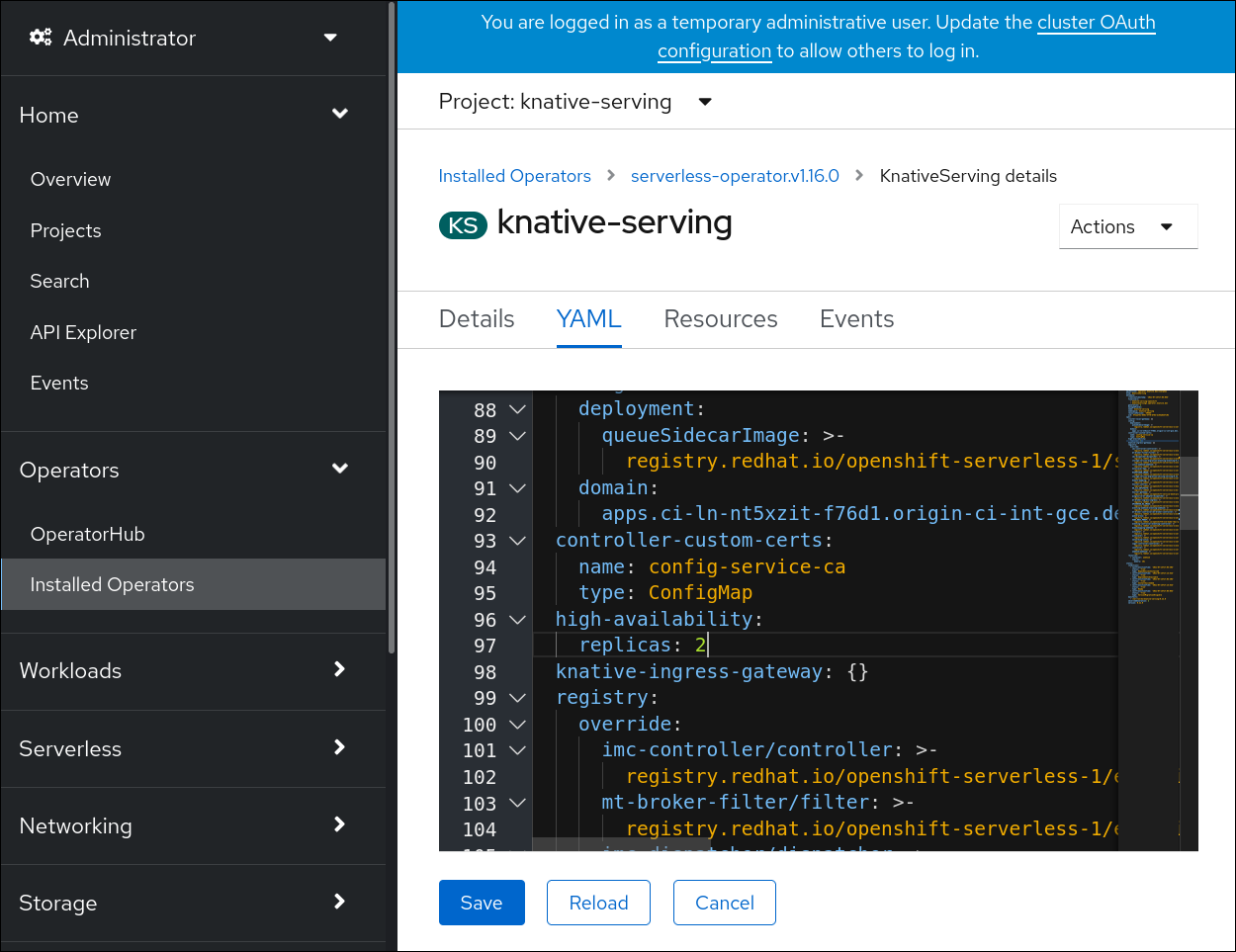

절차

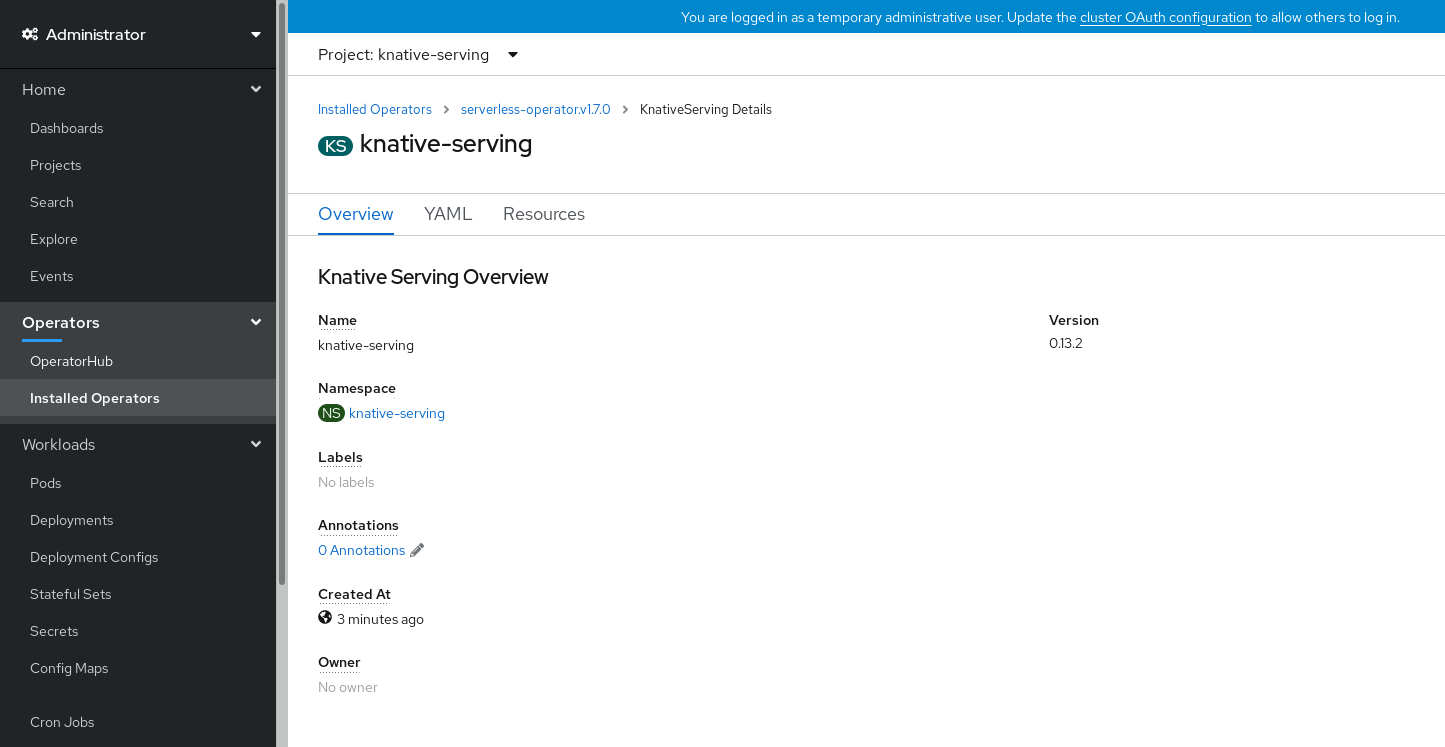

- OpenShift Container Platform 웹 콘솔의 관리자 화면에서 Operator → 설치된 Operator로 이동합니다.

- 페이지 상단에 있는 프로젝트 드롭다운이 Project: knative-serving으로 설정되어 있는지 확인합니다.

- OpenShift Serverless Operator의 제공되는 API 목록에서 Knative Serving을 클릭하여 Knative Serving 탭으로 이동합니다.

- Knative Serving 생성을 클릭합니다.

Knative Serving 생성 페이지에서 생성을 클릭하면 기본 설정을 사용하여 Knative Serving을 설치할 수 있습니다.

제공된 양식을 사용하여

KnativeServing오브젝트를 편집하거나 YAML을 편집하여 Knative Serving 설치에 대한 설정을 수정할 수도 있습니다.-

해당 양식은

KnativeServing오브젝트 생성을 완전히 제어할 필요가 없는 단순한 구성에 사용하는 것이 좋습니다. KnativeServing오브젝트 생성을 완전히 제어해야 하는 복잡한 구성의 경우 YAML을 편집하는 것이 좋습니다. Knative Serving 생성 페이지의 오른쪽 상단에 있는 YAML 편집 링크를 클릭하여 YAML에 액세스할 수 있습니다.양식을 작성하거나 YAML을 수정한 후 생성을 클릭합니다.

참고KnativeServing 사용자 정의 리소스 정의의 구성 옵션에 대한 자세한 내용은 고급 설치 구성 옵션 설명서를 참조하십시오.

-

해당 양식은

-

Knative Serving 설치가 완료되면

KnativeServing오브젝트가 생성되고 Knative Serving 탭으로 자동으로 이동합니다. 리소스 목록에knative-serving사용자 정의 리소스가 표시됩니다.

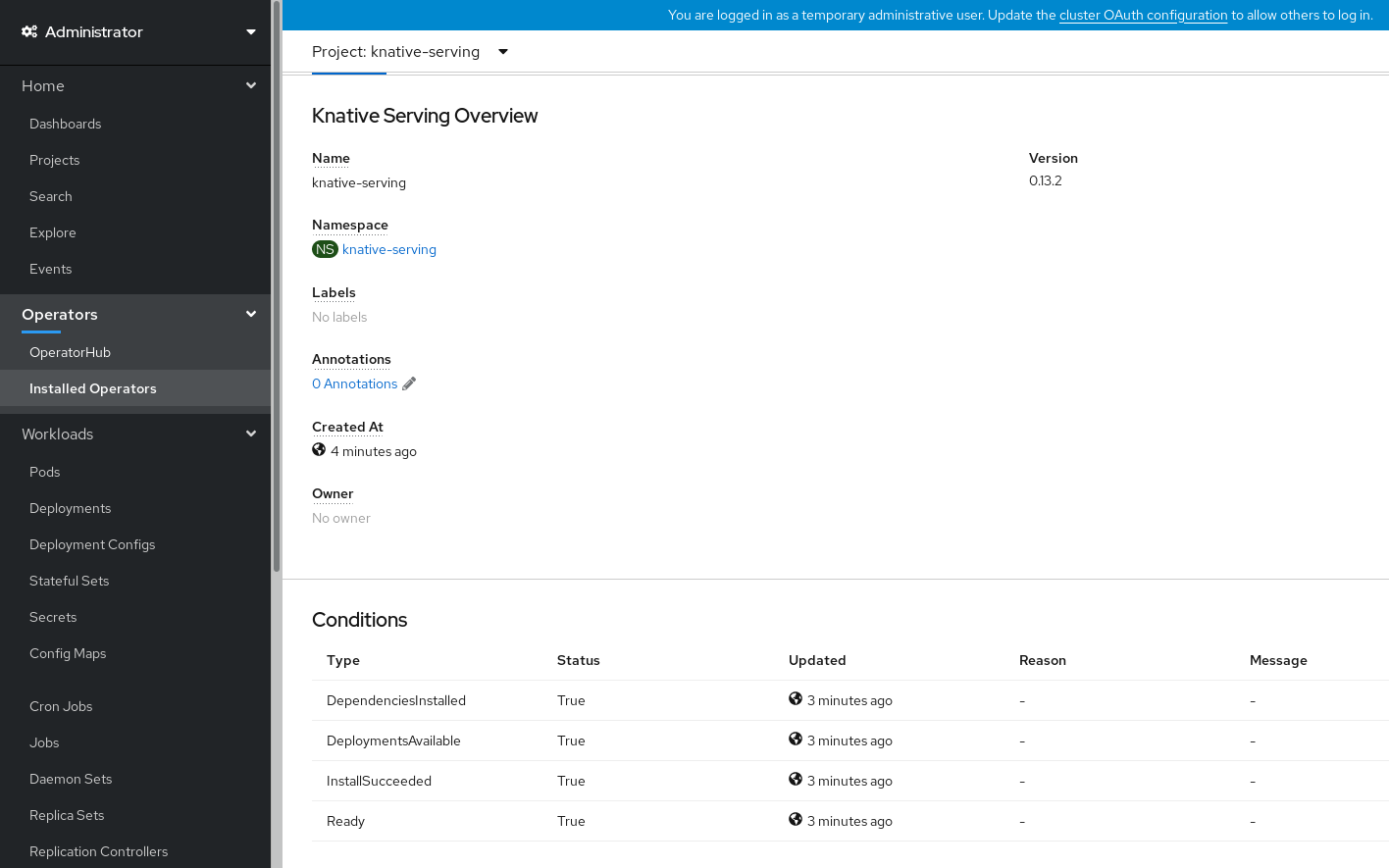

검증

-

Knative Serving 탭에서

knative-serving사용자 정의 리소스를 클릭합니다. 그러면 Knative Serving 개요 페이지로 자동으로 이동합니다.

- 조건 목록을 보려면 아래로 스크롤합니다.

예제 이미지에 표시된 대로 상태가 True인 조건 목록이 표시되어야 합니다.

참고Knative Serving 리소스를 생성하는 데 몇 초가 걸릴 수 있습니다. 리소스 탭에서 해당 상태를 확인할 수 있습니다.

- 조건이 알 수 없음 또는 False 상태인 경우 몇 분 정도 기다렸다가 리소스가 생성된 것을 확인한 후 다시 확인하십시오.

3.4.2. YAML을 사용하여 Knative Serving 설치

OpenShift Serverless Operator를 설치한 후 기본 설정을 사용하여 Knative Serving을 설치하거나 KnativeServing 사용자 정의 리소스(CR)에서 고급 설정을 구성할 수 있습니다. 다음 절차에 따라 YAML 파일 및 oc CLI를 사용하여 Knative Serving을 설치할 수 있습니다.

사전 요구 사항

- 클러스터 관리자 액세스 권한이 있는 OpenShift Container Platform 계정에 액세스할 수 있습니다.

- OpenShift Serverless Operator를 설치했습니다.

-

OpenShift CLI(

oc)를 설치합니다.

프로세스

serving.yaml이라는 파일을 생성하고 다음 예제 YAML을 이 파일에 복사합니다.apiVersion: operator.knative.dev/v1beta1 kind: KnativeServing metadata: name: knative-serving namespace: knative-servingapiVersion: operator.knative.dev/v1beta1 kind: KnativeServing metadata: name: knative-serving namespace: knative-servingCopy to Clipboard Copied! Toggle word wrap Toggle overflow serving.yaml파일을 적용합니다.oc apply -f serving.yaml

$ oc apply -f serving.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

설치가 완료되었는지 확인하려면 다음 명령을 입력합니다.

oc get knativeserving.operator.knative.dev/knative-serving -n knative-serving --template='{{range .status.conditions}}{{printf "%s=%s\n" .type .status}}{{end}}'$ oc get knativeserving.operator.knative.dev/knative-serving -n knative-serving --template='{{range .status.conditions}}{{printf "%s=%s\n" .type .status}}{{end}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

DependenciesInstalled=True DeploymentsAvailable=True InstallSucceeded=True Ready=True

DependenciesInstalled=True DeploymentsAvailable=True InstallSucceeded=True Ready=TrueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고Knative Serving 리소스를 생성하는 데 몇 초가 걸릴 수 있습니다.

조건이

알 수 없음또는False상태인 경우 몇 분 정도 기다렸다가 리소스가 생성된 것을 확인한 후 다시 확인하십시오.Knative Serving 리소스가 생성되었는지 확인합니다.

oc get pods -n knative-serving

$ oc get pods -n knative-servingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 필요한 네트워킹 구성 요소가 자동으로 생성된

knative-serving-ingress네임스페이스에 설치되어 있는지 확인합니다.oc get pods -n knative-serving-ingress

$ oc get pods -n knative-serving-ingressCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME READY STATUS RESTARTS AGE net-kourier-controller-7d4b6c5d95-62mkf 1/1 Running 0 76s net-kourier-controller-7d4b6c5d95-qmgm2 1/1 Running 0 76s 3scale-kourier-gateway-6688b49568-987qz 1/1 Running 0 75s 3scale-kourier-gateway-6688b49568-b5tnp 1/1 Running 0 75s

NAME READY STATUS RESTARTS AGE net-kourier-controller-7d4b6c5d95-62mkf 1/1 Running 0 76s net-kourier-controller-7d4b6c5d95-qmgm2 1/1 Running 0 76s 3scale-kourier-gateway-6688b49568-987qz 1/1 Running 0 75s 3scale-kourier-gateway-6688b49568-b5tnp 1/1 Running 0 75sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.3. 다음 단계

- Knative 이벤트 기반 아키텍처를 사용하려면 Knative Eventing을 설치할 수 있습니다.

3.5. Knative Eventing 설치

클러스터에서 이벤트 중심 아키텍처를 사용하려면 Knative Eventing을 설치합니다. 이벤트 소스, 브로커 및 채널과 같은 Knative 구성 요소를 생성한 다음 이를 사용하여 애플리케이션 또는 외부 시스템에 이벤트를 전송할 수 있습니다.

OpenShift Serverless Operator를 설치한 후 기본 설정을 사용하여 Knative Eventing을 설치하거나 KnativeEventing 사용자 정의 리소스(CR)에서 고급 설정을 구성할 수 있습니다. KnativeEventing CR의 구성 옵션에 대한 자세한 내용은 글로벌 구성을 참조하십시오.

OpenShift Serverless에서 Red Hat OpenShift 분산 추적을 사용하려면 Knative Eventing을 설치하기 전에 Red Hat OpenShift distributed tracing을 설치하고 구성해야 합니다.

3.5.1. 웹 콘솔을 사용하여 Knative Eventing 설치

OpenShift Serverless Operator를 설치한 후 OpenShift Container Platform 웹 콘솔을 사용하여 Knative Eventing을 설치합니다. 기본 설정을 사용하여 Knative Eventing을 설치하거나 KnativeEventing 사용자 정의 리소스(CR)에서 고급 설정을 구성할 수 있습니다.

사전 요구 사항

- 클러스터 관리자 액세스 권한이 있는 OpenShift Container Platform 계정에 액세스할 수 있습니다.

- OpenShift Container Platform 웹 콘솔에 로그인했습니다.

- OpenShift Serverless Operator를 설치했습니다.

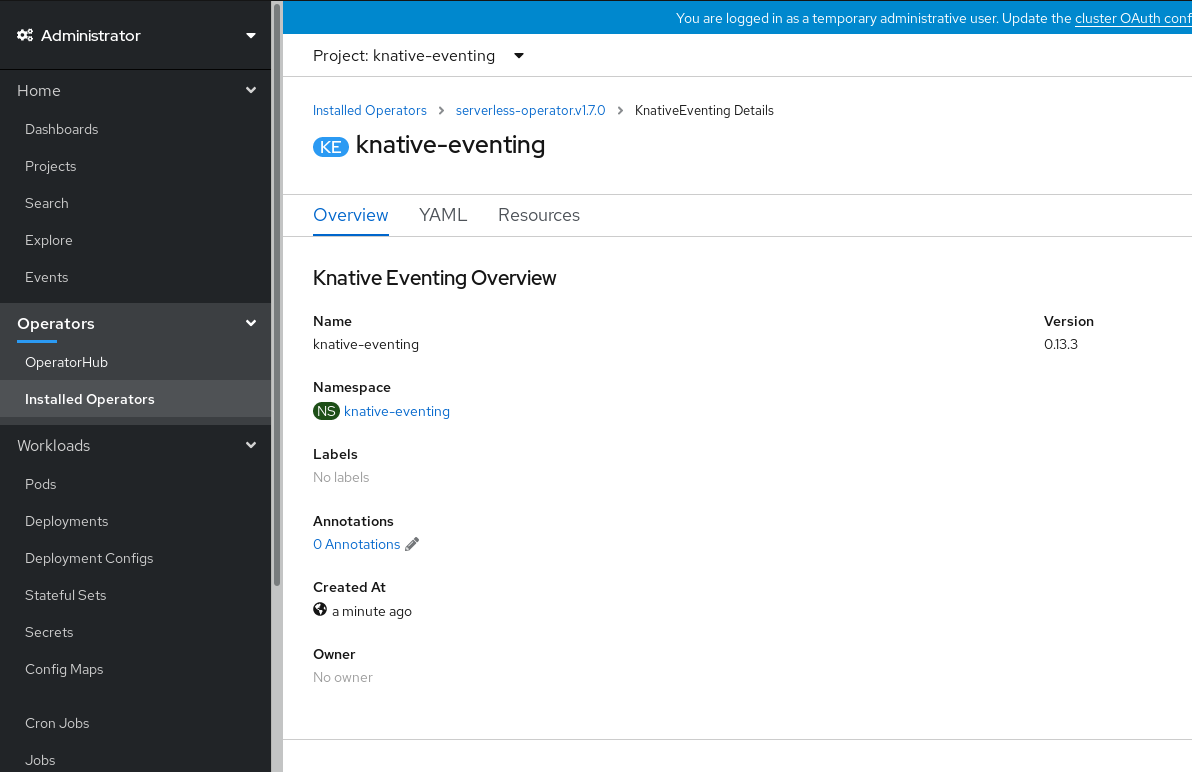

절차

- OpenShift Container Platform 웹 콘솔의 관리자 화면에서 Operator → 설치된 Operator로 이동합니다.

- 페이지 상단에 있는 프로젝트 드롭다운이 Project: knative-eventing으로 설정되어 있는지 확인합니다.

- OpenShift Serverless Operator의 제공되는 API 목록에서 Knative Eventing을 클릭하여 Knative Eventing 탭으로 이동합니다.

- Knative Eventing 생성을 클릭합니다.

Knative Eventing 생성 페이지에서 제공된 기본 양식을 사용하거나 YAML을 편집하여

KnativeEventing오브젝트를 구성하도록 선택할 수 있습니다.해당 양식은

KnativeEventing오브젝트 생성을 완전히 제어할 필요가 없는 단순한 구성에 사용하는 것이 좋습니다.선택 사항입니다. 양식을 사용하여

KnativeEventing오브젝트를 구성하는 경우 Knative Eventing 배포에 구현하려는 변경을 수행합니다.

생성을 클릭합니다.

KnativeEventing오브젝트 생성을 완전히 제어해야 하는 복잡한 구성의 경우 YAML을 편집하는 것이 좋습니다. Knative Eventing 생성 페이지의 오른쪽 상단에 있는 YAML 편집 링크를 클릭하여 YAML에 액세스할 수 있습니다.선택 사항입니다. YAML을 편집하여

KnativeEventing오브젝트를 구성하는 경우 YAML에 Knative Eventing 배포에 구현하려는 변경을 수행합니다.

- 생성을 클릭합니다.

-

Knative Eventing을 설치하면

KnativeEventing오브젝트가 생성되고 Knative Eventing 탭으로 자동으로 이동합니다. 리소스 목록에knative-eventing사용자 정의 리소스가 표시됩니다.

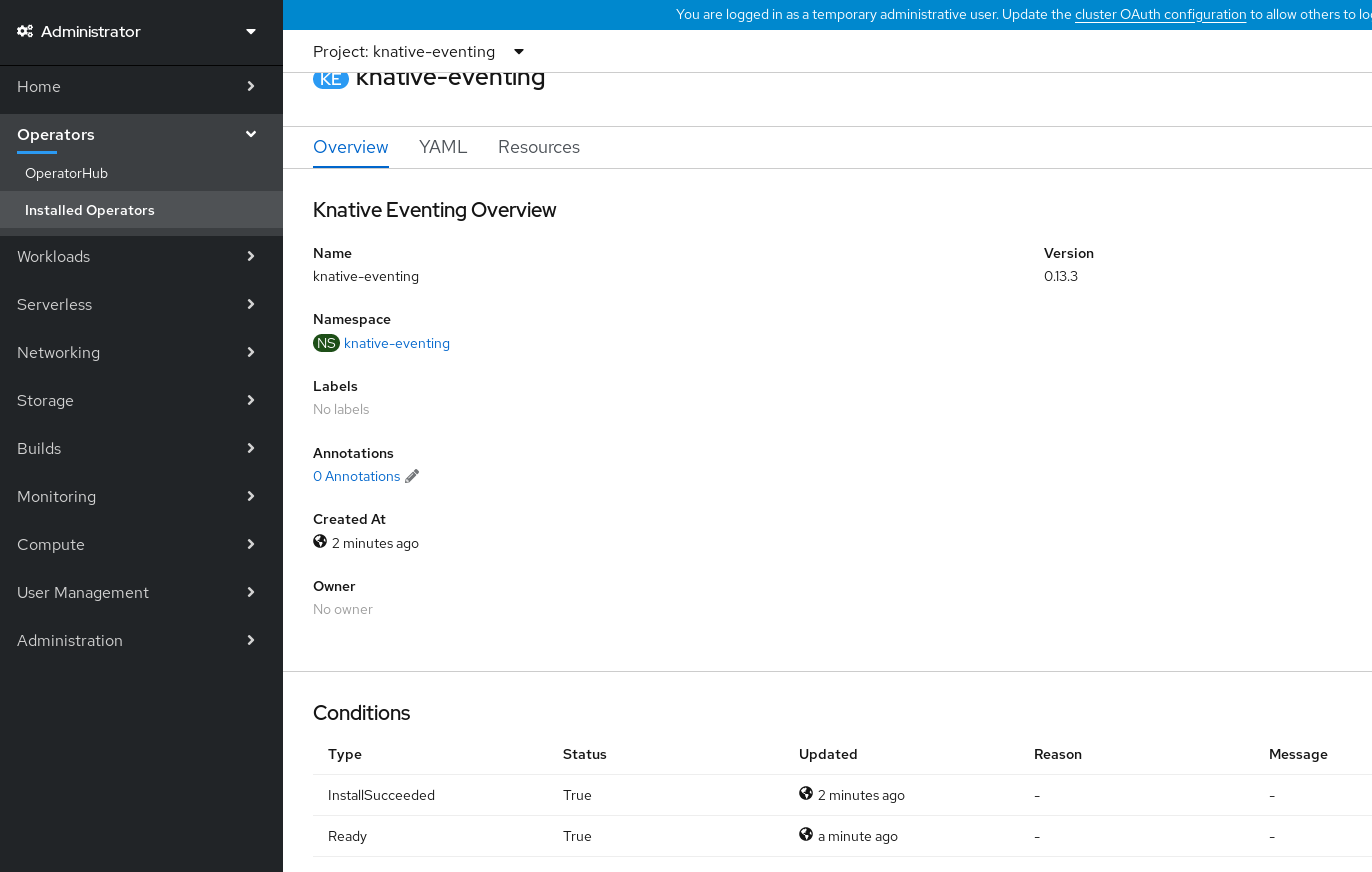

검증

-

Knative Eventing 탭에서

knative-eventing사용자 정의 리소스를 클릭합니다. 그러면 Knative Eventing 개요 페이지로 자동으로 이동합니다.

- 조건 목록을 보려면 아래로 스크롤합니다.

예제 이미지에 표시된 대로 상태가 True인 조건 목록이 표시되어야 합니다.

참고Knative Eventing 리소스를 생성하는 데 몇 초가 걸릴 수 있습니다. 리소스 탭에서 해당 상태를 확인할 수 있습니다.

- 조건이 알 수 없음 또는 False 상태인 경우 몇 분 정도 기다렸다가 리소스가 생성된 것을 확인한 후 다시 확인하십시오.

3.5.2. YAML을 사용하여 Knative Eventing 설치

OpenShift Serverless Operator를 설치한 후 기본 설정을 사용하여 Knative Eventing을 설치하거나 KnativeEventing 사용자 정의 리소스(CR)에서 고급 설정을 구성할 수 있습니다. 다음 절차에 따라 YAML 파일 및 oc CLI를 사용하여 Knative Eventing을 설치할 수 있습니다.

사전 요구 사항

- 클러스터 관리자 액세스 권한이 있는 OpenShift Container Platform 계정에 액세스할 수 있습니다.

- OpenShift Serverless Operator를 설치했습니다.

-

OpenShift CLI(

oc)를 설치합니다.

절차

-

eventing.yaml이라는 파일을 생성합니다. 다음 샘플 YAML을

eventing.yaml에 복사합니다.apiVersion: operator.knative.dev/v1beta1 kind: KnativeEventing metadata: name: knative-eventing namespace: knative-eventingapiVersion: operator.knative.dev/v1beta1 kind: KnativeEventing metadata: name: knative-eventing namespace: knative-eventingCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 선택 사항입니다. Knative Eventing 배포를 위해 구현하려는 YAML을 변경합니다.

다음을 입력하여

eventing.yaml파일을 적용합니다.oc apply -f eventing.yaml

$ oc apply -f eventing.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

다음 명령을 입력하고 출력을 관찰하여 설치가 완료되었는지 확인합니다.

oc get knativeeventing.operator.knative.dev/knative-eventing \ -n knative-eventing \ --template='{{range .status.conditions}}{{printf "%s=%s\n" .type .status}}{{end}}'$ oc get knativeeventing.operator.knative.dev/knative-eventing \ -n knative-eventing \ --template='{{range .status.conditions}}{{printf "%s=%s\n" .type .status}}{{end}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

InstallSucceeded=True Ready=True

InstallSucceeded=True Ready=TrueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고Knative Eventing 리소스를 생성하는 데 몇 초가 걸릴 수 있습니다.

-

조건이

알 수 없음또는False상태인 경우 몇 분 정도 기다렸다가 리소스가 생성된 것을 확인한 후 다시 확인하십시오. 다음을 입력하여 Knative Eventing 리소스가 생성되었는지 확인합니다.

oc get pods -n knative-eventing

$ oc get pods -n knative-eventingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5.3. Knative Kafka 설치

Knative Kafka는 OpenShift Serverless에서 지원되는 Apache Kafka 메시지 스트리밍 플랫폼을 사용할 수 있는 통합 옵션을 제공합니다. Knative Kafka 기능은 KnativeKafka 사용자 정의 리소스를 설치한 경우 OpenShift Serverless 설치에서 사용할 수 있습니다.

사전 요구 사항

- OpenShift Serverless Operator 및 Knative Eventing을 클러스터에 설치했습니다.

- Red Hat AMQ Streams 클러스터에 액세스할 수 있습니다.

-

확인 단계를 사용하려면 OpenShift CLI(

oc)를 설치합니다.

- OpenShift Container Platform에 대한 클러스터 관리자 권한이 있습니다.

- OpenShift Container Platform 웹 콘솔에 로그인되어 있습니다.

절차

- 관리자 화면에서 Operator → 설치된 Operator로 이동합니다.

- 페이지 상단에 있는 프로젝트 드롭다운이 Project: knative-eventing으로 설정되어 있는지 확인합니다.

- OpenShift Serverless Operator의 Provided APIs 목록에서 Knative Kafka를 검색하여 Create Instance를 클릭합니다.

Knative Kafka 생성 페이지에서 KnativeKafka 오브젝트를 구성합니다.

중요클러스터에서 Kafka 채널, 소스, 브로커 또는 싱크를 사용하려면 사용할 옵션에 대해 활성화된 스위치를 true 로 전환해야 합니다. 이러한 스위치는 기본적으로 false로 설정됩니다. 또한 Kafka 채널, 브로커 또는 싱크를 사용하려면 부트스트랩 서버를 지정해야 합니다.

KnativeKafka사용자 정의 리소스의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 개발자가 클러스터에서

KafkaChannel채널 유형을 사용할 수 있습니다. - 2

- AMQ Streams 클러스터에 있는 쉼표로 구분된 부트스트랩 서버 목록입니다.

- 3

- 개발자가 클러스터에서

KafkaSource이벤트 소스 유형을 사용할 수 있습니다. - 4

- 개발자가 클러스터에서 Knative Kafka 브로커 구현을 사용할 수 있습니다.

- 5

- Red Hat AMQ Streams 클러스터에서 쉼표로 구분된 부트스트랩 서버 목록입니다.

- 6

Broker오브젝트에서 지원하는 Kafka 항목의 파티션 수를 정의합니다. 기본값은10입니다.- 7

Broker오브젝트에서 지원하는 Kafka 항목의 복제 요소를 정의합니다. 기본값은3입니다.- 8

- 개발자가 클러스터에서 Kafka 싱크를 사용할 수 있습니다.

참고replicationfactor값은 Red Hat AMQ Streams 클러스터의 노드 수보다 작거나 같아야 합니다.- 해당 양식은 KnativeKafka 오브젝트 생성을 완전히 제어할 필요가 없는 단순한 구성에 사용하는 것이 좋습니다.

- KnativeKafka 오브젝트 생성을 완전히 제어해야 하는 복잡한 구성의 경우 YAML을 편집하는 것이 좋습니다. Knative Kafka 생성 페이지의 오른쪽 상단에 있는 YAML 편집 링크를 클릭하여 YAML에 액세스할 수 있습니다.

- Kafka에 대한 선택적 구성을 완료한 후 생성을 클릭합니다. 그러면 리소스 목록에 knative-kafka가 있는 Knative Kafka 탭으로 자동으로 이동합니다.

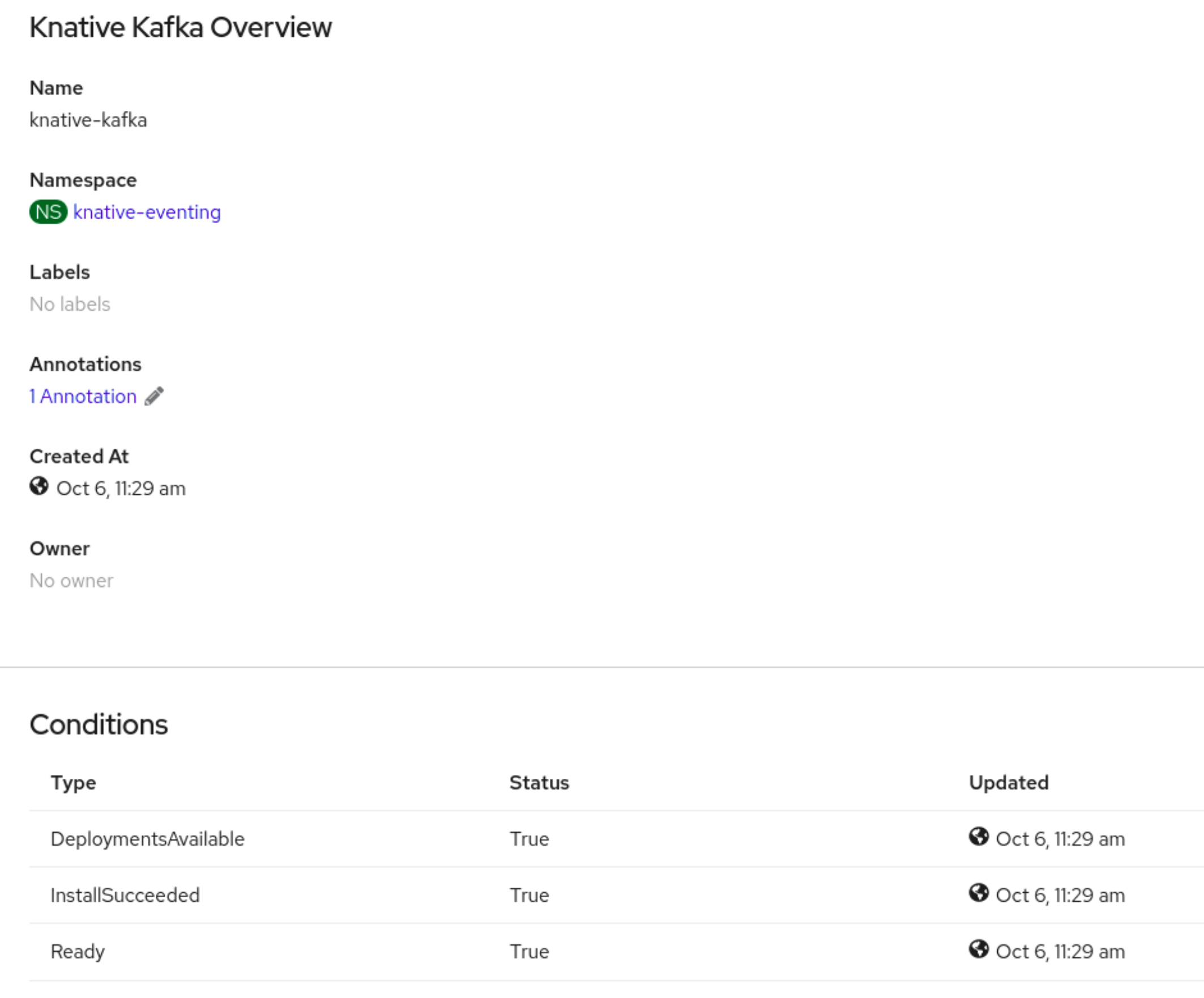

검증

- Knative Kafka 탭에서 knative-kafka 리소스를 클릭합니다. 그러면 자동으로 Knative Kafka 개요 페이지로 이동합니다.

리소스에 대한 조건 목록을 확인하고 상태가 True인지 확인합니다.

조건 상태가 알 수 없음 또는 False인 경우 몇 분 정도 기다린 후 페이지를 새로 고칩니다.

Knative Kafka 리소스가 생성되었는지 확인합니다.

oc get pods -n knative-eventing

$ oc get pods -n knative-eventingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5.4. 다음 단계

- Knative 서비스를 사용하려면 Knative Serving을 설치할 수 있습니다.

3.6. Knative Kafka 구성

Knative Kafka는 OpenShift Serverless에서 지원되는 Apache Kafka 메시지 스트리밍 플랫폼을 사용할 수 있는 통합 옵션을 제공합니다. Kafka는 이벤트 소스, 채널, 브로커 및 이벤트 싱크 기능에 대한 옵션을 제공합니다.

클러스터 관리자는 핵심 OpenShift Serverless 설치의 일부로 제공되는 Knative Eventing 구성 요소 외에도 KnativeKafka CR(사용자 정의 리소스)을 설치할 수 있습니다.

Knative Kafka는 현재 IBM Z 및 IBM Power에서 지원되지 않습니다.

KnativeKafka CR은 다음과 같은 추가 옵션을 사용자에게 제공합니다.

- Kafka 소스

- Kafka 채널

- Kafka 브로커

- Kafka 싱크

3.7. OpenShift Serverless Functions 구성

애플리케이션 코드 배포 프로세스를 개선하기 위해 OpenShift Serverless를 사용하여 이벤트 중심 기능을 OpenShift Container Platform에서 Knative 서비스로 배포할 수 있습니다. 함수를 개발하려면 설정 단계를 완료해야 합니다.

3.7.1. 사전 요구 사항

클러스터에서 OpenShift Serverless Functions을 사용하려면 다음 단계를 완료해야 합니다.

OpenShift Serverless Operator 및 Knative Serving이 클러스터에 설치되어 있습니다.

참고함수는 Knative 서비스로 배포됩니다. 함수와 함께 이벤트 중심 아키텍처를 사용하려면 Knative Eventing도 설치해야 합니다.

-

ocCLI 가 설치되어 있어야 합니다. -

Knative(

kn) CLI 가 설치되어 있습니다. Knative CLI를 설치하면 함수를 생성하고 관리하는 데 사용할 수 있는kn func명령을 사용할 수 있습니다. - Docker Container Engine 또는 Podman 버전 3.4.7 이상이 설치되어 있습니다.

- OpenShift Container Registry와 같이 사용 가능한 이미지 레지스트리에 액세스할 수 있습니다.

- Quay.io 를 이미지 레지스트리로 사용하는 경우 리포지토리가 비공개가 아니거나 Pod가 다른 보안 레지스트리의 이미지를 참조하도록 허용하는 OpenShift Container Platform 문서를 따르는지 확인해야 합니다.

- OpenShift Container Registry를 사용하는 경우 클러스터 관리자가 레지스트리를 공개해야 합니다.

3.7.2. Podman 설정

고급 컨테이너 관리 기능을 사용하려면 OpenShift Serverless Functions와 함께 Podman을 사용할 수 있습니다. 이를 위해 Podman 서비스를 시작하고 Knative(kn) CLI를 구성하여 연결합니다.

절차

${XDG_RUNTIME_DIR}/podman/podman.sock:의 UNIX 소켓에서 Docker API를 제공하는 Podman 서비스를 시작합니다.systemctl start --user podman.socket

$ systemctl start --user podman.socketCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고대부분의 시스템에서 이 소켓은

/run/user/$(id -u)/podman/podman.sock에 있습니다.기능을 구축하는 데 사용되는 환경 변수를 설정합니다.

export DOCKER_HOST="unix://${XDG_RUNTIME_DIR}/podman/podman.sock"$ export DOCKER_HOST="unix://${XDG_RUNTIME_DIR}/podman/podman.sock"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 자세한 출력을 보려면

-v플래그를 사용하여 함수 프로젝트 디렉터리 내에서 build 명령을 실행합니다. 로컬 UNIX 소켓에 대한 연결이 표시됩니다.kn func build -v

$ kn func build -vCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.7.3. macOS에서 Podman 설정

고급 컨테이너 관리 기능을 사용하려면 OpenShift Serverless Functions와 함께 Podman을 사용할 수 있습니다. macOS에서 이 작업을 수행하려면 Podman 머신을 시작하고 Knative(kn) CLI를 구성하여 연결합니다.

절차

Podman 시스템을 생성합니다.

podman machine init --memory=8192 --cpus=2 --disk-size=20

$ podman machine init --memory=8192 --cpus=2 --disk-size=20Copy to Clipboard Copied! Toggle word wrap Toggle overflow UNIX 소켓에서 Docker API를 제공하는 Podman 시스템을 시작합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고대부분의 macOS 시스템에서 이 소켓은

/Users/myuser/.local/share/containers/podman/machine/podman-default/podman.sock에 있습니다.기능을 구축하는 데 사용되는 환경 변수를 설정합니다.

export DOCKER_HOST='unix:///Users/myuser/.local/share/containers/podman/machine/podman-machine-default/podman.sock'

$ export DOCKER_HOST='unix:///Users/myuser/.local/share/containers/podman/machine/podman-machine-default/podman.sock'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 자세한 출력을 보려면

-v플래그를 사용하여 함수 프로젝트 디렉터리 내에서 build 명령을 실행합니다. 로컬 UNIX 소켓에 대한 연결이 표시됩니다.kn func build -v

$ kn func build -vCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.7.4. 다음 단계

3.8. 서버리스 업그레이드

릴리스 버전을 건너뛰지 않고 OpenShift Serverless를 업그레이드해야 합니다. 이 섹션에서는 업그레이드 문제를 해결하는 방법을 설명합니다.

3.8.1. OpenShift Serverless Operator 업그레이드 실패 확인

예를 들어 수동으로 설치 제거하고 다시 설치할 때 OpenShift Serverless Operator를 업그레이드할 때 오류가 발생할 수 있습니다. 오류가 발생하면 OpenShift Serverless Operator를 수동으로 다시 설치해야 합니다.

절차

OpenShift Serverless 릴리스 노트에서 검색하여 원래 설치된 OpenShift Serverless Operator 버전을 확인합니다.

예를 들어 업그레이드 시도 중 오류 메시지에 다음 문자열이 포함될 수 있습니다.

The installed KnativeServing version is v1.5.0.

The installed KnativeServing version is v1.5.0.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 예에서 KnativeServing

MAJOR.MINOR버전은1.5입니다. 이 버전은 OpenShift Serverless 1.26: OpenShift Serverless의 릴리스 노트에서 현재 Knative Serving 1.5를 사용합니다.- OpenShift Serverless Operator 및 모든 설치 계획을 설치 제거합니다.

첫 번째 단계에서 검색한 OpenShift Serverless Operator 버전을 수동으로 설치합니다. 설치하려면 다음 예와 같이 먼저

서버리스-subscription.yaml파일을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 그런 다음 다음 명령을 실행하여 서브스크립션을 설치합니다.

oc apply -f serverless-subscription.yaml

$ oc apply -f serverless-subscription.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 표시되는 대로 업그레이드 설치 계획을 수동으로 승인합니다.

4장. 서빙

4.1. Knative Serving 시작하기

4.1.1. 서버리스 애플리케이션

서버리스 애플리케이션은 경로 및 구성으로 정의되고 YAML 파일에 포함된 Kubernetes 서비스로 생성 및 배포됩니다. OpenShift Serverless를 사용하여 서버리스 애플리케이션을 배포하려면 Knative Service 오브젝트를 생성해야 합니다.

Knative Service 오브젝트 YAML 파일의 예

다음 방법 중 하나를 사용하여 서버리스 애플리케이션을 생성합니다.

OpenShift Container Platform 웹 콘솔에서 Knative 서비스를 생성합니다.

자세한 내용은 개발자 화면을 사용하여 애플리케이션 생성을 참조하십시오.

-

Knative(

kn) CLI를 사용하여 Knative 서비스를 생성합니다. -

ocCLI를 사용하여 KnativeService오브젝트를 YAML 파일로 생성하고 적용합니다.

4.1.1.1. Knative CLI를 사용하여 서버리스 애플리케이션 생성

Knative(kn) CLI를 사용하여 서버리스 애플리케이션을 생성하면 YAML 파일을 직접 수정하는 것보다 더 간소화되고 직관적인 사용자 인터페이스를 제공합니다. kn service create 명령을 사용하여 기본 서버리스 애플리케이션을 생성할 수 있습니다.

사전 요구 사항

- OpenShift Serverless Operator 및 Knative Serving이 클러스터에 설치되어 있습니다.

-

Knative(

kn) CLI가 설치되어 있습니다. - 프로젝트를 생성했거나 OpenShift Container Platform에서 애플리케이션 및 기타 워크로드를 생성하는 데 적절한 역할 및 권한이 있는 프로젝트에 액세스할 수 있습니다.

절차

Knative 서비스를 생성합니다.

kn service create <service-name> --image <image> --tag <tag-value>

$ kn service create <service-name> --image <image> --tag <tag-value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

-

--image는 애플리케이션의 이미지 URI입니다. --tag는 서비스로 생성된 초기 버전에 태그를 추가하는 데 사용할 수 있는 선택적 플래그입니다.명령 예

kn service create event-display \ --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest$ kn service create event-display \ --image quay.io/openshift-knative/knative-eventing-sources-event-display:latestCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

4.1.1.2. YAML을 사용하여 서버리스 애플리케이션 생성

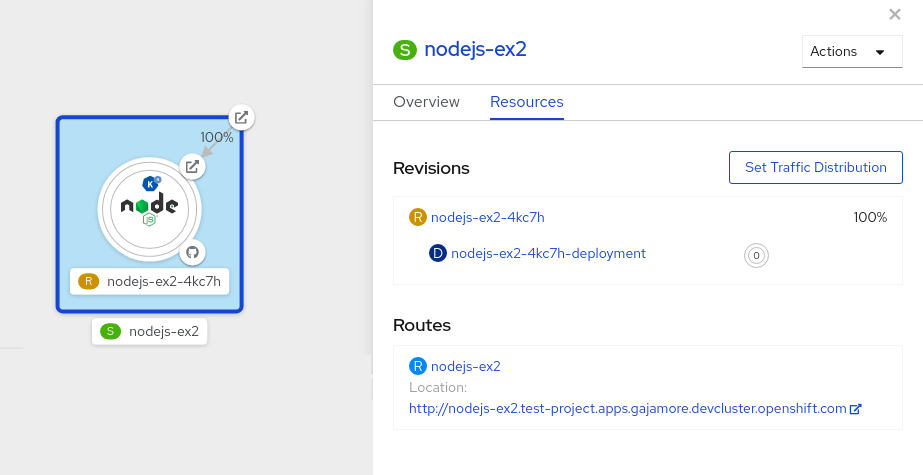

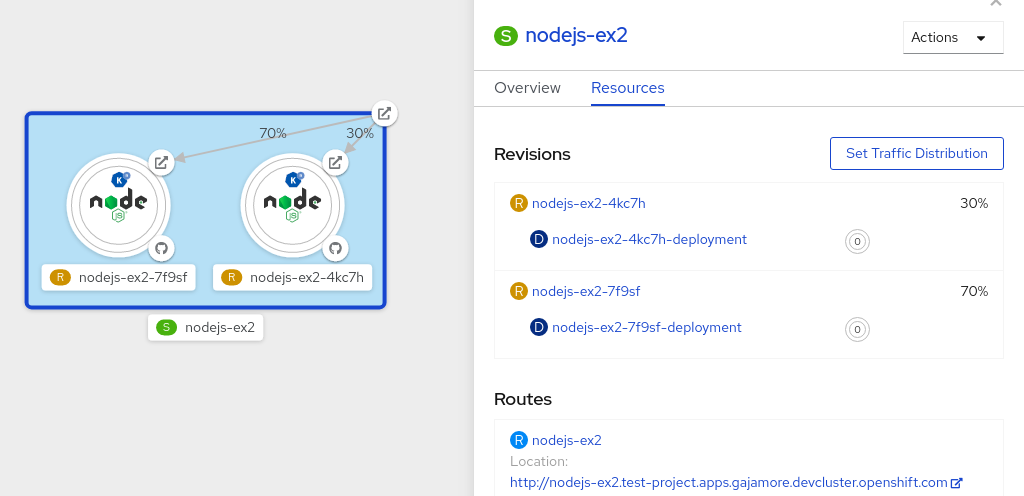

YAML 파일을 사용하여 Knative 리소스를 생성하면 선언적 API를 사용하므로 애플리케이션을 선언적으로, 재현 가능한 방식으로 설명할 수 있습니다. YAML을 사용하여 서버리스 애플리케이션을 생성하려면 Knative Service 오브젝트를 정의하는 YAML 파일을 생성한 다음 oc apply 를 사용하여 적용해야 합니다.

서비스가 생성되고 애플리케이션이 배포되면 Knative에서 이 버전의 애플리케이션에 대해 변경할 수 없는 버전을 생성합니다. Knative는 또한 네트워크 프로그래밍을 수행하여 애플리케이션의 경로, 수신, 서비스 및 로드 밸런서를 생성하고 트래픽에 따라 Pod를 자동으로 확장합니다.

사전 요구 사항

- OpenShift Serverless Operator 및 Knative Serving이 클러스터에 설치되어 있습니다.

- 프로젝트를 생성했거나 OpenShift Container Platform에서 애플리케이션 및 기타 워크로드를 생성하는 데 적절한 역할 및 권한이 있는 프로젝트에 액세스할 수 있습니다.

-

OpenShift CLI(

oc)를 설치합니다.

절차

다음 샘플 코드를 포함하는 YAML 파일을 생성합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow YAML 파일이 포함된 디렉터리로 이동한 후 YAML 파일을 적용하여 애플리케이션을 배포합니다.

oc apply -f <filename>

$ oc apply -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

OpenShift Container Platform 웹 콘솔의 개발자 화면으로 전환하거나 Knative(kn) CLI 또는 YAML 파일을 사용하지 않으려면 OpenShift Container Platform 웹 콘솔의 Administator 화면을 사용하여 Knative 구성 요소를 생성할 수 있습니다.

4.1.1.3. 관리자 화면을 사용하여 서버리스 애플리케이션 생성

서버리스 애플리케이션은 경로 및 구성으로 정의되고 YAML 파일에 포함된 Kubernetes 서비스로 생성 및 배포됩니다. OpenShift Serverless를 사용하여 서버리스 애플리케이션을 배포하려면 Knative Service 오브젝트를 생성해야 합니다.

Knative Service 오브젝트 YAML 파일의 예

서비스가 생성되고 애플리케이션이 배포되면 Knative에서 이 버전의 애플리케이션에 대해 변경할 수 없는 버전을 생성합니다. Knative는 또한 네트워크 프로그래밍을 수행하여 애플리케이션의 경로, 수신, 서비스 및 로드 밸런서를 생성하고 트래픽에 따라 Pod를 자동으로 확장합니다.

사전 요구 사항

관리자 화면을 사용하여 서버리스 애플리케이션을 생성하려면 다음 단계를 완료해야 합니다.

- OpenShift Serverless Operator 및 Knative Serving이 설치되어 있습니다.

- 웹 콘솔에 로그인한 후 관리자 화면에 있습니다.

절차

- Serverless → Serving 페이지로 이동합니다.

- 생성 목록에서 서비스를 선택합니다.

- YAML 또는 JSON 정의를 수동으로 입력하거나 파일을 편집기로 끌어서 놓습니다.

- 생성을 클릭합니다.

4.1.1.4. 오프라인 모드를 사용하여 서비스 생성

오프라인 모드에서 kn service 명령을 실행하여 클러스터에서 변경 사항이 발생하지 않고, 대신 로컬 머신에 서비스 설명자 파일이 생성됩니다. 설명자 파일이 생성되면 클러스터에 변경 사항을 전파하기 전에 파일을 수정할 수 있습니다.

Knative CLI의 오프라인 모드는 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 기술 프리뷰 기능 지원 범위를 참조하십시오.

사전 요구 사항

- OpenShift Serverless Operator 및 Knative Serving이 클러스터에 설치되어 있습니다.

-

Knative(

kn) CLI가 설치되어 있습니다.

절차

오프라인 모드에서 로컬 Knative 서비스 설명자 파일을 생성합니다.

kn service create event-display \ --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest \ --target ./ \ --namespace test$ kn service create event-display \ --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest \ --target ./ \ --namespace testCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Service 'event-display' created in namespace 'test'.

Service 'event-display' created in namespace 'test'.Copy to Clipboard Copied! Toggle word wrap Toggle overflow --target ./플래그는 오프라인 모드를 활성화하고 새 디렉터리 트리를 저장하는 디렉토리로./를 지정합니다.기존 디렉터리를 지정하지 않고

--target my-service.yaml과 같은 파일 이름을 사용하면 디렉터리 트리가 생성되지 않습니다. 대신 서비스 설명자 파일my-service.yaml만 현재 디렉터리에 생성됩니다.파일 이름에는.

.yaml,.yml, 또는.json확장을 사용할 수 있습니다..json을 선택하면 JSON 형식으로 서비스 설명자 파일을 생성합니다.--namespace test옵션은 새 서비스를test네임스페이스에 배치합니다.--namespace를사용하지 않고 OpenShift Container Platform 클러스터에 로그인한 경우 현재 네임스페이스에 설명자 파일이 생성됩니다. 그렇지 않으면 설명자 파일이default네임스페이스에 생성됩니다.

생성된 디렉터리 구조를 확인합니다.

tree ./

$ tree ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

--target에서 지정된 현재./디렉터리에는 지정된 네임스페이스를 바탕으로 이름이 지정된test/디렉터리가 포함되어 있습니다. -

test/디렉터리에는 리소스 유형의 이름에 따라 이름이 지정된ksvc디렉터리가 포함되어 있습니다. -

ksvc디렉터리에는 지정된 서비스 이름에 따라 이름이 지정된 기술자 파일event-display.yaml이 포함되어 있습니다.

-

생성된 서비스 기술자 파일을 확인합니다.

cat test/ksvc/event-display.yaml

$ cat test/ksvc/event-display.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 새 서비스에 대한 정보를 나열합니다.

kn service describe event-display --target ./ --namespace test

$ kn service describe event-display --target ./ --namespace testCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow target ./옵션은 네임스페이스 하위 디렉터리를 포함하는 디렉터리 구조의 루트 디렉터리를 지정합니다.또는

--target옵션을 사용하여 YAML 또는 JSON 파일 이름을 직접 지정할 수 있습니다. 허용된 파일 확장자는.yaml,.yml,.json입니다.--namespace옵션은 필요한 서비스 기술자 파일을 포함하는 하위 디렉터리를kn와 통신하는 네임스페이스를 지정합니다.--namespace를 사용하지 않고 OpenShift Container Platform 클러스터에 로그인한 경우kn은 현재 네임스페이스를 바탕으로 이름이 지정된 하위 디렉터리에서 서비스를 검색합니다. 그렇지 않으면kn은default/하위 디렉터리에서 검색합니다.

서비스 설명자 파일을 사용하여 클러스터에 서비스를 생성합니다.

kn service create -f test/ksvc/event-display.yaml

$ kn service create -f test/ksvc/event-display.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.2. 서버리스 애플리케이션 배포 확인

서버리스 애플리케이션이 성공적으로 배포되었는지 확인하려면 Knative에서 생성한 애플리케이션 URL을 가져와서 해당 URL로 요청을 보낸 후 출력을 관찰해야 합니다. OpenShift Serverless에서는 HTTP 및 HTTPS URL을 모두 지원하지만 oc get ksvc 출력에서는 http:// 형식을 사용하여 항상 URL을 출력합니다.

4.1.2.1. 서버리스 애플리케이션 배포 확인

서버리스 애플리케이션이 성공적으로 배포되었는지 확인하려면 Knative에서 생성한 애플리케이션 URL을 가져와서 해당 URL로 요청을 보낸 후 출력을 관찰해야 합니다. OpenShift Serverless에서는 HTTP 및 HTTPS URL을 모두 지원하지만 oc get ksvc 출력에서는 http:// 형식을 사용하여 항상 URL을 출력합니다.

사전 요구 사항

- OpenShift Serverless Operator 및 Knative Serving이 클러스터에 설치되어 있습니다.

-

ocCLI를 설치했습니다. - Knative 서비스가 생성되어 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다.

절차

애플리케이션 URL을 찾습니다.

oc get ksvc <service_name>

$ oc get ksvc <service_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME URL LATESTCREATED LATESTREADY READY REASON event-delivery http://event-delivery-default.example.com event-delivery-4wsd2 event-delivery-4wsd2 True

NAME URL LATESTCREATED LATESTREADY READY REASON event-delivery http://event-delivery-default.example.com event-delivery-4wsd2 event-delivery-4wsd2 TrueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 클러스터에 요청한 후 출력을 확인합니다.

HTTP 요청의 예

curl http://event-delivery-default.example.com

$ curl http://event-delivery-default.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow HTTPS 요청의 예

curl https://event-delivery-default.example.com

$ curl https://event-delivery-default.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Hello Serverless!

Hello Serverless!Copy to Clipboard Copied! Toggle word wrap Toggle overflow 선택 사항입니다. 인증서 체인에서 자체 서명된 인증서와 관련된 오류가 발생하면

--insecure플래그를 curl 명령에 추가하여 오류를 무시할 수 있습니다.curl https://event-delivery-default.example.com --insecure

$ curl https://event-delivery-default.example.com --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Hello Serverless!

Hello Serverless!Copy to Clipboard Copied! Toggle word wrap Toggle overflow 중요프로덕션 배포에는 자체 서명된 인증서를 사용해서는 안 됩니다. 이 방법은 테스트 목적으로만 사용됩니다.

선택 사항입니다. OpenShift Container Platform 클러스터가 CA(인증 기관)에서 서명한 인증서로 구성되어 있지만 아직 시스템에 전역적으로 구성되지 않은 경우

curl명령으로 이 인증서를 지정할 수 있습니다. 인증서 경로는--cacert플래그를 사용하여 curl 명령에 전달할 수 있습니다.curl https://event-delivery-default.example.com --cacert <file>

$ curl https://event-delivery-default.example.com --cacert <file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Hello Serverless!

Hello Serverless!Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2. 자동 확장

4.2.1. 자동 확장

Knative Serving은 들어오는 수요와 일치시킬 수 있도록 애플리케이션이 자동 스케일링 또는 자동 스케일링 을 제공합니다. 예를 들어 애플리케이션에 트래픽이 없고 scale-to-zero가 활성화된 경우 Knative Serving은 애플리케이션을 복제본 0으로 축소합니다. scale-to-zero이 비활성화된 경우 애플리케이션은 클러스터의 애플리케이션에 대해 구성된 최소 복제본 수로 축소됩니다. 애플리케이션 트래픽이 증가하는 경우 요구에 맞게 복제본을 확장할 수도 있습니다.

Knative 서비스의 자동 스케일링 설정은 클러스터 관리자가 구성하거나 개별 서비스에 대해 구성된 설정별로 구성하는 전역 설정일 수 있습니다.

서비스의 YAML 파일을 수정하거나 Knative(kn) CLI를 사용하여 OpenShift Container Platform 웹 콘솔을 사용하여 서비스 단위 설정을 수정할 수 있습니다.

서비스에 설정된 모든 제한 또는 대상은 애플리케이션의 단일 인스턴스에 대해 측정됩니다. 예를 들어 target 주석을 50 으로 설정하면 자동 스케일러가 애플리케이션을 스케일링하여 각 버전이 한 번에 50개의 요청을 처리하도록 구성됩니다.

4.2.2. scale bounds

scale bounds는 언제든지 애플리케이션을 제공할 수 있는 최소 및 최대 복제본 수를 결정합니다. 애플리케이션에 대한 스케일 경계를 설정하여 콜드 시작 방지 또는 컴퓨팅 비용을 제어할 수 있습니다.

4.2.2.1. 최소 스케일링 범위

애플리케이션을 제공할 수 있는 최소 복제본 수는 min-scale 주석에 따라 결정됩니다. scale to zero가 활성화되어 있지 않으면 min-scale 값이 1 로 설정됩니다.

다음 조건이 충족되는 경우 min-scale 값은 기본적으로 0 개의 복제본으로 설정됩니다.

-

min-scale주석이 설정되지 않음 - 스케일링을 0으로 활성화

-

KPA클래스가 사용됩니다.

min-scale 주석이 있는 서비스 사양의 예

4.2.2.1.1. Knative CLI를 사용하여 min-scale 주석 설정

Knative(kn) CLI를 사용하여 min-scale 주석을 설정하면 YAML 파일을 직접 수정하는 동안 보다 간소화되고 직관적인 사용자 인터페이스를 제공합니다. kn service 명령을 --scale-min 플래그와 함께 사용하여 서비스의 min-scale 값을 생성하거나 수정할 수 있습니다.

사전 요구 사항

- Knative Serving이 클러스터에 설치되어 있습니다.

-

Knative(

kn) CLI가 설치되어 있습니다.

절차

--scale-min플래그를 사용하여 서비스의 최소 복제본 수를 설정합니다.kn service create <service_name> --image <image_uri> --scale-min <integer>

$ kn service create <service_name> --image <image_uri> --scale-min <integer>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 명령 예

kn service create example-service --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest --scale-min 2

$ kn service create example-service --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest --scale-min 2Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.2.2. 최대 스케일링 범위

애플리케이션을 제공할 수 있는 최대 복제본 수는 max-scale 주석에 따라 결정됩니다. max-scale 주석이 설정되지 않은 경우 생성된 복제본 수에 대한 상한이 없습니다.

max-scale 주석이 있는 서비스 사양의 예

4.2.2.2.1. Knative CLI를 사용하여 max-scale 주석 설정

Knative(kn) CLI를 사용하여 max-scale 주석을 설정하면 YAML 파일을 직접 수정하여 보다 간소화되고 직관적인 사용자 인터페이스를 제공합니다. kn service 명령을 --scale-max 플래그와 함께 사용하여 서비스의 max-scale 값을 생성하거나 수정할 수 있습니다.

사전 요구 사항

- Knative Serving이 클러스터에 설치되어 있습니다.

-

Knative(

kn) CLI가 설치되어 있습니다.

절차

--scale-max플래그를 사용하여 서비스의 최대 복제본 수를 설정합니다.kn service create <service_name> --image <image_uri> --scale-max <integer>

$ kn service create <service_name> --image <image_uri> --scale-max <integer>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 명령 예

kn service create example-service --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest --scale-max 10

$ kn service create example-service --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest --scale-max 10Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.3. 동시성

동시성은 언제든지 애플리케이션의 각 복제본에서 처리할 수 있는 동시 요청 수를 결정합니다. 동시성은 소프트 제한 또는 하드 제한 으로 구성할 수 있습니다.

- 소프트 제한은 엄격하게 적용되는 바인딩된 것이 아니라 대상 요청 제한입니다. 예를 들어, 트래픽 버스트가 급증하는 경우 소프트 제한 대상을 초과할 수 있습니다.

하드 제한은 엄격한 강제 적용된 상한 요청 제한입니다. 동시성이 하드 제한에 도달하면 요청을 버퍼링하고 요청을 실행하기에 충분한 여유 용량이 있을 때까지 기다려야 합니다.If concurrency reaches the hard limit, surplus requests are buffered and must wait until there is enough free capacity to execute the requests.

중요애플리케이션에 대한 명확한 사용 사례가 있는 경우에만 하드 제한 구성을 사용하는 것이 좋습니다. 지정된 하드 제한이 낮으면 애플리케이션의 처리량 및 대기 시간에 부정적인 영향을 미칠 수 있으며 콜드 시작이 발생할 수 있습니다.

소프트 대상과 하드 제한을 추가하면 자동 스케일러가 동시 요청의 소프트 대상 수를 대상으로하지만 최대 요청 수에 하드 제한 값을 강제 적용합니다.

하드 제한 값이 소프트 제한 값보다 작으면 실제로 처리할 수 있는 수보다 더 많은 요청을 대상으로 할 필요가 없기 때문에 소프트 제한 값이 축소됩니다.

4.2.3.1. 소프트 동시성 대상 구성

소프트 제한은 엄격하게 적용되는 바인딩된 것이 아니라 대상 요청 제한입니다. 예를 들어, 트래픽 버스트가 급증하는 경우 소프트 제한 대상을 초과할 수 있습니다. 사양에 autoscaling.knative.dev/target 주석을 설정하거나 올바른 플래그와 함께 kn service 명령을 사용하여 Knative 서비스의 소프트 동시성 대상을 지정할 수 있습니다.

절차

선택 사항:

Service사용자 정의 리소스의 사양에서 Knative 서비스에 대한autoscaling.knative.dev/target주석을 설정합니다.서비스 사양의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 선택 사항:

kn service명령을 사용하여--concurrency-target플래그를 지정합니다.kn service create <service_name> --image <image_uri> --concurrency-target <integer>

$ kn service create <service_name> --image <image_uri> --concurrency-target <integer>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 동시성 대상이 50개의 요청인 서비스를 생성하는 명령의 예

kn service create example-service --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest --concurrency-target 50

$ kn service create example-service --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest --concurrency-target 50Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.3.2. 하드 동시성 제한 구성

하드 동시성 제한은 엄격히 적용되는 상한 상한 요청 제한입니다. 동시성이 하드 제한에 도달하면 요청을 버퍼링하고 요청을 실행하기에 충분한 여유 용량이 있을 때까지 기다려야 합니다.If concurrency reaches the hard limit, surplus requests are buffered and must wait until there is enough free capacity to execute the requests. containerConcurrency 사양을 수정하거나 올바른 플래그와 함께 kn service 명령을 사용하여 Knative 서비스의 하드 동시성 제한을 지정할 수 있습니다.

절차

선택 사항:

Service사용자 정의 리소스의 사양에서 Knative 서비스의containerConcurrency사양을 설정합니다.서비스 사양의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 기본값은

0이며, 이는 한 번에 하나의 서비스 복제본으로 흐름을 허용하는 동시 요청 수에 제한이 없음을 의미합니다.값이

0보다 크면 한 번에 하나의 서비스 복제본으로 흐름이 허용되는 정확한 요청 수를 지정합니다. 이 예제에서는 50개의 요청의 하드 동시성 제한을 활성화합니다.선택 사항:

kn service명령을 사용하여--concurrency-limit플래그를 지정합니다.kn service create <service_name> --image <image_uri> --concurrency-limit <integer>

$ kn service create <service_name> --image <image_uri> --concurrency-limit <integer>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 동시성 제한이 50개인 서비스를 생성하는 명령의 예

kn service create example-service --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest --concurrency-limit 50

$ kn service create example-service --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest --concurrency-limit 50Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.3.3. 동시성 대상 사용률

이 값은 자동 스케일러가 실제로 대상으로 하는 동시성 제한의 백분율을 지정합니다. 복제가 실행되는 hotness 를 지정하여 정의된 하드 제한에 도달하기 전에 자동 스케일러를 확장할 수도 있습니다.

예를 들어 containerConcurrency 값이 10으로 설정되고 target-utilization-percentage 값이 70%로 설정된 경우 기존 복제본의 평균 수가 7에 도달하면 자동 스케일러에서 새 복제본을 생성합니다. 7에서 10으로 번호가 매겨진 요청은 여전히 기존 복제본으로 전송되지만 containerConcurrency 값에 도달한 후 추가 복제본이 필요합니다.

target-utilization-percentage 주석을 사용하여 구성된 서비스 예

4.2.4. Scale-to-zero

Knative Serving은 들어오는 수요와 일치시킬 수 있도록 애플리케이션이 자동 스케일링 또는 자동 스케일링 을 제공합니다.

4.2.4.1. scale-to-zero 활성화

enable-scale-to-zero 사양을 사용하여 클러스터의 애플리케이션에 대해 전체적으로 scale-to-zero 사양을 활성화하거나 비활성화할 수 있습니다.

사전 요구 사항

- 클러스터에 OpenShift Serverless Operator 및 Knative Serving을 설치했습니다.

- 클러스터 관리자 권한이 있어야 합니다.

- 기본 Knative Pod Autoscaler를 사용하고 있습니다. Kubernetes Horizontal Pod Autoscaler를 사용하는 경우 제로 스케일링 기능을 사용할 수 없습니다.

절차

KnativeServing사용자 정의 리소스(CR)에서enable-scale-to-zero사양을 수정합니다.KnativeServing CR의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

enable-scale-to-zero사양은"true"또는"false"일 수 있습니다. true로 설정하면 scale-to-zero가 활성화됩니다. false로 설정하면 애플리케이션이 구성된 최소 스케일 바인딩 으로 축소됩니다. 기본값은"true"입니다.

4.2.4.2. scale-to-zero 유예 기간 구성

Knative Serving은 애플리케이션의 Pod를 0개로 자동 축소합니다. scale-to-zero-grace-period 사양을 사용하여 애플리케이션의 마지막 복제본이 제거되기 전에 Knative에서 0으로 머신 사이가 될 때까지 대기하는 상한 시간 제한을 정의할 수 있습니다.

사전 요구 사항

- 클러스터에 OpenShift Serverless Operator 및 Knative Serving을 설치했습니다.

- 클러스터 관리자 권한이 있어야 합니다.

- 기본 Knative Pod Autoscaler를 사용하고 있습니다. Kubernetes Horizontal Pod Autoscaler를 사용하는 경우 scale-to-zero 기능을 사용할 수 없습니다.

절차

KnativeServingCR(사용자 정의 리소스)에서scale-to-zero-grace-period사양을 수정합니다.KnativeServing CR의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 유예 기간(초)입니다. 기본값은 30초입니다.

4.3. Serverless 애플리케이션 구성

4.3.1. Knative Serving 시스템 배포 구성 덮어쓰기

KnativeServing CR(사용자 정의 리소스)에서 deployments 사양을 수정하여 일부 특정 배포 의 기본 구성을 덮어쓸 수 있습니다.

기본적으로 배포에 정의된 프로브만 재정의할 수 있습니다.

모든 Knative Serving 배포는 기본적으로 준비 상태 및 활성 상태 프로브를 정의합니다. 이러한 예외는 다음과 같습니다.

-

net-kourier-controller및3scale-kourier-gateway는 준비 상태 프로브만 정의합니다. -

net-istio-controller및net-istio-webhook는 프로브를 정의하지 않습니다.

4.3.1.1. 시스템 배포 구성 덮어쓰기

현재는 리소스,복제본,레이블,주석, nodeSelector 필드에는 기본 구성 설정을 재정의하고 프로브 의 준비 및 활성 필드에도 지원됩니다.

다음 예에서 KnativeServing CR은 다음과 같이 Webhook 배포를 덮어씁니다.

-

net-kourier-controller의준비 상태프로브 타임아웃이 10초로 설정됩니다. - 배포에 CPU 및 메모리 리소스 제한이 지정되었습니다.

- 배포에는 3개의 복제본이 있습니다.

-

example-label: 레이블레이블이 추가되었습니다. -

example-annotation: 주석주석이 추가되었습니다. -

nodeSelector필드는disktype: hdd레이블이 있는 노드를 선택하도록 설정됩니다.

KnativeServing CR 라벨 및 주석 설정은 배포 자체와 결과 Pod 모두에 대한 배포의 라벨 및 주석을 재정의합니다.

KnativeServing CR 예

- 1

준비상태 및 활성 상태 프로브덮어쓰기를 사용하여 프로브에 지정된 대로 Kubernetes API에 지정된 대로 배포 컨테이너에 있는 프로브의 모든 필드를 재정의할 수 있습니다. 그러나 프로브 처리기와 관련된 필드인exec,grpc,httpGet,tcpSocket.