OpenShift Dedicated 소개

OpenShift Dedicated 아키텍처 개요

초록

1장. OpenShift Dedicated 이해

Kubernetes에 기반을 둔 OpenShift Dedicated는 클라우드 서비스로 제공되는 완전한 OpenShift Container Platform 클러스터이며 고가용성을 위해 구성되며 단일 고객 전용으로 구성됩니다.

1.1. OpenShift Dedicated 개요

OpenShift Dedicated는 Red Hat에서 관리하며 AWS(Amazon Web Services) 또는 Google Cloud에서 호스팅됩니다. 각 OpenShift Dedicated 클러스터에는 완전히 관리되는 컨트롤 플레인 (Control 및 인프라 노드), Red Hat 사이트 안정성 엔지니어(SRE), 프리미엄 Red Hat 지원, 로깅, 메트릭, 모니터링, 알림 포털 및 클러스터 포털과 같은 클러스터 서비스가 포함되어 있습니다.

OpenShift Dedicated는 다음과 같은 향상된 기능을 포함하여 Kubernetes에 엔터프라이즈급 개선 사항을 제공합니다.

- OpenShift Dedicated 클러스터는 AWS 또는 Google Cloud 환경에 배포되며 애플리케이션 관리를 위한 하이브리드 접근 방식의 일부로 사용할 수 있습니다.

- 통합된 Red Hat 기술. OpenShift Dedicated의 주요 구성 요소는 Red Hat Enterprise Linux 및 관련 Red Hat 기술을 기반으로 합니다. OpenShift Dedicated는 Red Hat의 엔터프라이즈급 소프트웨어에 대한 강력한 테스트 및 인증 이니셔티브의 이점을 제공합니다.

- 오픈 소스 개발 모델. 개발은 공개적으로 완료되었으며 소스 코드는 공개 소프트웨어 리포지토리에서 구할 수 있습니다. 이 오픈 협업을 통해 빠른 혁신과 개발을 촉진할 수 있습니다.

OpenShift Container Platform에서 컨테이너화된 Kubernetes 애플리케이션을 빌드하고 배포할 때 생성할 수 있는 자산 옵션에 대한 자세한 내용은 OpenShift Container Platform 개발 이해 를 참조하십시오.

1.1.1. 사용자 정의 운영 체제

OpenShift Dedicated는 CoreOS 및 Red Hat Atomic Host 운영 체제의 최상의 기능과 기능을 결합하는 컨테이너 지향 운영 체제인 RHCOS(Red Hat Enterprise Linux CoreOS)를 사용합니다. RHCOS는 OpenShift Dedicated에서 컨테이너화된 애플리케이션을 실행하도록 특별히 설계되었으며 새로운 툴과 함께 작동하여 빠른 설치, Operator 기반 관리 및 단순화된 업그레이드를 제공합니다.

RHCOS는 다음을 포함합니다.

- OpenShift Dedicated가 머신을 처음 시작하고 구성하기 위한 최초 부팅 시스템 구성으로 사용하는 Ignition

- 운영 체제와 밀접하게 통합되어 효율적이고 최적화된 Kubernetes 환경을 제공하는 Kubernetes 기본 컨테이너 런타임 구현인 CRI-O. CRI-O는 컨테이너 실행, 중지 및 다시 시작 기능을 제공합니다.

- 컨테이너 시작 및 모니터링을 담당하는 Kubernetes의 기본 노드 에이전트인 Kubelet

1.1.2. 기타 주요 기능

Operator는 OpenShift Dedicated 코드 베이스의 기본 단위이자 애플리케이션 및 애플리케이션에서 사용할 소프트웨어 구성 요소를 편리하게 배포할 수 있는 방법입니다. OpenShift Dedicated에서 Operator는 플랫폼 기반 역할을 하며 운영 체제 및 컨트롤 플레인 애플리케이션을 수동으로 업그레이드할 필요가 없습니다. Cluster Version Operator 및 Machine Config Operator와 같은 OpenShift Dedicated Operator를 사용하면 중요한 구성 요소를 클러스터 전체로 관리할 수 있습니다.

OLM(Operator Lifecycle Manager) 및 소프트웨어 카탈로그는 애플리케이션을 개발하고 배포하는 사용자에게 Operator를 저장하고 배포하는 기능을 제공합니다.

{quay} 컨테이너 레지스트리는 대부분의 컨테이너 이미지 및 Operator를 OpenShift Dedicated 클러스터에 제공하는 Quay.io 컨테이너 레지스트리입니다. Quay.io는 수백만 개의 이미지와 태그를 저장하는 {quay}의 공개 레지스트리 버전입니다.

OpenShift Dedicated의 Kubernetes의 기타 개선 사항에는 소프트웨어 정의 네트워킹(SDN), 인증, 로그 집계, 모니터링 및 라우팅 개선 사항이 포함됩니다. OpenShift Dedicated에서는 포괄적인 웹 콘솔 및 사용자 정의 OpenShift CLI(oc) 인터페이스도 제공합니다.

1.1.3. OpenShift Dedicated에 대한 인터넷 및 Telemetry 액세스

OpenShift Dedicated에서 클러스터를 설치하고 업그레이드하려면 인터넷 액세스가 필요합니다.

Telemetry 서비스를 통해 서브스크립션 관리 자동화를 활성화하고 클러스터 상태를 모니터링하고, 지원 및 고객 환경을 개선하기 위해 OpenShift Dedicated 클러스터에서 Red Hat으로 정보가 전송됩니다.

Telemetry 서비스가 자동으로 실행되고 클러스터는 Red Hat OpenShift Cluster Manager에 등록됩니다. OpenShift Dedicated에서는 원격 상태 보고가 항상 활성화되어 있으며 옵트아웃할 수 없습니다. Red Hat SRE(Site Reliability Engineering) 팀에서는 OpenShift Dedicated 클러스터에 대한 효과적인 지원을 제공하기 위해 정보가 필요합니다.

2장. 정책 및 서비스 정의

2.1. OpenShift Dedicated 서비스 정의

2.1.1. 계정 관리

2.1.1.1. 청구 옵션

고객은 OSD(OpenShift Dedicated)의 연간 서브스크립션을 구입하거나 클라우드 마켓플레이스를 통해 온디맨드로 사용할 수 있는 옵션이 있습니다. 고객은 고객 클라우드 서브스크립션(CCS)이라는 자체 클라우드 인프라 계정을 가져오거나 Red Hat이 소유한 클라우드 공급자 계정에 배포할 수 있습니다. 아래 표에서는 청구 및 지원되는 배포 옵션에 대한 추가 정보를 제공합니다.

| OSD 서브스크립션 유형 | 클라우드 인프라 계정 | 청구됨 |

|---|---|---|

| Red Hat을 통한 연간 고정 용량 서브스크립션 | Red Hat 클라우드 계정 | OSD 서브스크립션 및 클라우드 인프라 모두에 사용되는 Red Hat |

| 고객의 클라우드 계정 | OSD 서브스크립션 사용을 위해 Red Hat 클라우드 인프라 사용을 위한 클라우드 공급자 | |

| Google Cloud Marketplace를 통한 온디맨드 사용 기반 사용 | 고객의 Google Cloud 계정 | 클라우드 인프라 및 Red Hat OSD 서브스크립션 모두를 위한 Google Cloud |

CSS(Customer Cloud Subscription)라고 하는 자체 클라우드 인프라 계정을 사용하는 고객은 클라우드 인프라 비용을 줄이기 위해 예약된 인스턴스(RI) 컴퓨팅 인스턴스를 사전 구매하거나 제공해야 합니다.

다음을 포함하여 OpenShift Dedicated 클러스터에 대한 추가 리소스를 구입할 수 있습니다.

- 추가 노드(머신 풀을 사용하여 다양한 유형 및 크기일 수 있음)

- 미들웨어(JBoss EAP, JBoss Fuse 등) - 특정 미들웨어 구성 요소에 따른 추가 가격

- 500GB의 추가 스토리지(CCS만 해당, 100GB 포함)

- 추가 12 TiB 네트워크 I/O (CCS 전용, 12TB 포함)

- 서비스의 로드 밸런서는 4번의 번들로 사용할 수 있습니다. HTTP/SNI 트래픽 또는 비표준 포트(CCS만 해당)를 활성화합니다.

2.1.1.2. 클러스터 셀프 서비스

고객은 필요한 서브스크립션을 이미 구매한 경우 OpenShift Cluster Manager 에서 클러스터를 생성, 확장 및 삭제할 수 있습니다.

Red Hat OpenShift Cluster Manager에서 사용 가능한 작업은 클러스터 내에서 직접 수행하지 않아야 합니다. 이로 인해 모든 작업이 자동으로 되돌리는 것을 포함하여 부정적인 영향을 미칠 수 있습니다.

2.1.1.3. 클라우드 공급자

OpenShift Dedicated는 다음 클라우드 공급자에서 OpenShift Container Platform 클러스터를 관리형 서비스로 제공합니다.

- AWS(Amazon Web Services)

- Google Cloud

2.1.1.4. 인스턴스 유형

단일 가용성 영역 클러스터에는 단일 가용성 영역에 배포된 CCO(Customer Cloud Subscription) 클러스터의 최소 2개의 작업자 노드가 필요합니다. CCS가 아닌 클러스터에는 최소 4개의 작업자 노드가 필요합니다. 이 4개의 작업자 노드는 기본 서브스크립션에 포함되어 있습니다.

여러 가용성 영역 클러스터에는 고객 클라우드 서브스크립션(CCS) 클러스터용 최소 3개의 작업자 노드가 필요하며 1개는 3개의 가용성 영역 각각에 배포됩니다. CCS가 아닌 클러스터에는 최소 9개의 작업자 노드가 필요합니다. 이 9개의 작업자 노드는 기본 서브스크립션에 포함되어 있으며 적절한 노드 배포를 유지하려면 추가 노드를 3의 배수로 구매해야 합니다.

단일 OpenShift Dedicated 머신 풀 내의 모든 작업자 노드는 동일한 유형과 크기여야 합니다. 그러나 OpenShift Dedicated 클러스터 내의 여러 머신 풀의 작업자 노드는 다양한 유형과 크기일 수 있습니다.

컨트롤 플레인 및 인프라 노드는 Red Hat에서 배포 및 관리합니다. etcd 및 API 관련 워크로드를 처리하는 컨트롤 플레인 노드가 3개 이상 있습니다. 메트릭, 라우팅, 웹 콘솔 및 기타 워크로드를 처리하는 인프라 노드가 2개 이상 있습니다. 컨트롤 플레인 및 인프라 노드에서 워크로드를 실행하지 않아야 합니다. 실행하려는 모든 워크로드는 작업자 노드에 배포해야 합니다.

클라우드 공급자 콘솔을 통해 기본 인프라를 종료하는 것은 지원되지 않으며 데이터 손실이 발생할 수 있습니다.

작업자 노드에 배포해야 하는 Red Hat 워크로드에 대한 자세한 내용은 다음 Red Hat Operator 지원 섹션을 참조하십시오.

약 1개의 vCPU 코어 및 1GiB의 메모리는 각 작업자 노드에 예약되고 할당 가능한 리소스에서 제거됩니다. 이는 기본 플랫폼에 필요한 프로세스를 실행하는 데 필요합니다. 여기에는 udev, kubelet, 컨테이너 런타임 등과 같은 시스템 데몬과 커널 예약도 포함됩니다. 감사 로그 집계, 메트릭 컬렉션, DNS, 이미지 레지스트리, SDN 등과 같은 OpenShift Container Platform 핵심 시스템은 클러스터의 안정성과 유지 관리를 유지하기 위해 추가 할당 가능한 리소스를 사용할 수 있습니다. 소비된 추가 리소스는 사용량에 따라 다를 수 있습니다.

OpenShift Dedicated 4.11부터 기본 Pod당 PID 제한은 4096 입니다. 이 PID 제한을 활성화하려면 OpenShift Dedicated 클러스터를 이 버전 이상으로 업그레이드해야 합니다. 4.11 이전 버전을 실행하는 OpenShift Dedicated 클러스터는 기본 PID 제한을 1024 로 제한합니다.

OpenShift Dedicated 클러스터에서는 Pod별 PID 제한을 구성할 수 없습니다.

추가 리소스

2.1.1.5. 고객 클라우드 서브스크립션 클러스터의 AWS 인스턴스 유형

OpenShift Dedicated는 AWS에서 다음과 같은 작업자 노드 인스턴스 유형 및 크기를 제공합니다.

예 2.1. 일반 목적

- m5.metal (96 Cryostat vCPU, 384GiB)

- m5.xlarge (4 vCPU, 16GiB)

- m5.2xlarge (8 vCPU, 32GiB)

- m5.4xlarge (16 vCPU, 64GiB)

- m5.8xlarge(32 vCPU, 128GiB)

- m5.12xlarge (48 vCPU, 192GiB)

- m5.16xlarge (64 vCPU, 256GiB)

- m5.24xlarge (96 vCPU, 384GiB)

- m5a.xlarge (4 vCPU, 16GiB)

- m5a.2xlarge (8 vCPU, 32GiB)

- m5a.4xlarge (16 vCPU, 64GiB)

- m5a.8xlarge(32 vCPU, 128GiB)

- m5a.12xlarge (48 vCPU, 192GiB)

- m5a.16xlarge (64 vCPU, 256GiB)

- m5a.24xlarge (96 vCPU, 384GiB)

- m5ad.xlarge (4 vCPU, 16GiB)

- m5ad.2xlarge (8 vCPU, 32GiB)

- m5ad.4xlarge (16 vCPU, 64GiB)

- m5ad.8xlarge(32 vCPU, 128GiB)

- m5ad.12xlarge (48 vCPU, 192GiB)

- m5ad.16xlarge (64 vCPU, 256GiB)

- m5ad.24xlarge (96 vCPU, 384GiB)

- m5d.metal (96 Cryostat vCPU, 384GiB)

- m5d.xlarge (4 vCPU, 16GiB)

- m5d.2xlarge (8 vCPU, 32GiB)

- m5d.4xlarge (16 vCPU, 64GiB)

- m5d.8xlarge(32 vCPU, 128GiB)

- m5d.12xlarge (48 vCPU, 192GiB)

- m5d.16xlarge (64 vCPU, 256GiB)

- m5d.24xlarge (96 vCPU, 384GiB)

- m5n.metal (96 vCPU, 384GiB)

- m5n.xlarge (4 vCPU, 16GiB)

- m5n.2xlarge (8 vCPU, 32GiB)

- m5n.4xlarge (16 vCPU, 64GiB)

- m5n.8xlarge(32 vCPU, 128GiB)

- m5n.12xlarge (48 vCPU, 192GiB)

- m5n.16xlarge (64 vCPU, 256GiB)

- m5n.24xlarge (96 vCPU, 384GiB)

- m5dn.metal (96 vCPU, 384GiB)

- m5dn.xlarge (4 vCPU, 16GiB)

- m5dn.2xlarge (8 vCPU, 32GiB)

- m5dn.4xlarge (16 vCPU, 64GiB)

- m5dn.8xlarge(32 vCPU, 128GiB)

- m5dn.12xlarge (48 vCPU, 192GiB)

- m5dn.16xlarge (64 vCPU, 256GiB)

- m5dn.24xlarge (96 vCPU, 384GiB)

- m5zn.metal (48 vCPU, 192GiB)

- m5zn.xlarge (4 vCPU, 16GiB)

- m5zn.2xlarge (8 vCPU, 32GiB)

- m5zn.3xlarge (12 vCPU, 48GiB)

- m5zn.6xlarge (24 vCPU, 96GiB)

- m5zn.12xlarge (48 vCPU, 192GiB)

- m6a.xlarge (4 vCPU, 16GiB)

- m6a.2xlarge (8 vCPU, 32GiB)

- m6a.4xlarge (16 vCPU, 64GiB)

- m6a.8xlarge(32 vCPU, 128GiB)

- m6a.12xlarge (48 vCPU, 192GiB)

- m6a.16xlarge (64 vCPU, 256GiB)

- m6a.24xlarge (96 vCPU, 384GiB)

- m6a.32xlarge(128 vCPU, 512GiB)

- m6a.48xlarge (192 vCPU, 768GiB)

- m6i.metal(128 vCPU, 512GiB)

- m6i.xlarge (4 vCPU, 16GiB)

- m6i.2xlarge (8 vCPU, 32GiB)

- m6i.4xlarge (16 vCPU, 64GiB)

- m6i.8xlarge(32 vCPU, 128GiB)

- m6i.12xlarge (48 vCPU, 192GiB)

- m6i.16xlarge (64 vCPU, 256GiB)

- m6i.24xlarge (96 vCPU, 384GiB)

- m6i.32xlarge(128 vCPU, 512GiB)

- m6id.xlarge (4 vCPU, 16GiB)

- m6id.2xlarge (8 vCPU, 32GiB)

- m6id.4xlarge (16 vCPU, 64GiB)

- m6id.8xlarge(32 vCPU, 128GiB)

- m6id.12xlarge (48 vCPU, 192GiB)

- m6id.16xlarge (64 vCPU, 256GiB)

- m6id.24xlarge (96 vCPU, 384GiB)

- m6id.32xlarge(128 vCPU, 512GiB)

- m7i.xlarge (4 vCPU, 16GiB)

- m7i.2xlarge (8 vCPU, 32GiB)

- m7i.4xlarge (16 vCPU, 64GiB)

- m7i.8xlarge(32 vCPU, 128GiB)

- m7i.12xlarge (48 vCPU, 192GiB)

- m7i.16xlarge (64 vCPU, 256GiB)

- m7i.24xlarge (96 vCPU, 384GiB)

- m7i.48xlarge (192 vCPU, 768GiB)

- m7i.metal-24xl (96 vCPU, 384GiB)

- m7i.metal-48xl (192 vCPU, 768GiB)

- m7i-flex.xlarge (4 vCPU, 16GiB)

- m7i-flex.2xlarge (8 vCPU, 32GiB)

- m7i-flex.4xlarge (16 vCPU, 64GiB)

- m7i-flex.8xlarge(32 vCPU, 128GiB)

- m7a.xlarge (4 vCPU, 16GiB)

- m7a.2xlarge (8 vCPU, 32GiB)

- m7a.4xlarge (16 vCPU, 64GiB)

- m7a.8xlarge(32 vCPU, 128GiB)

- m7a.12xlarge (48 vCPU, 192GiB)

- m7a.16xlarge (64 vCPU, 256GiB)

- m7a.24xlarge (96 vCPU, 384GiB)

- m7a.32xlarge(128 vCPU, 512GiB)

- m7a.48xlarge (192 vCPU, 768GiB)

- m7a.metal-48xl (192 vCPU, 768GiB)

이러한 인스턴스 유형은 48개의 물리적 코어에 96 논리 프로세서를 제공합니다. 두 개의 물리적 Intel 소켓이 있는 단일 서버에서 실행됩니다.

예 2.2. Burstable 일반 목적

- t3.xlarge (4 vCPU, 16GiB)

- t3.2xlarge (8 vCPU, 32GiB)

- t3a.xlarge (4 vCPU, 16GiB)

- t3a.2xlarge (8 vCPU, 32GiB)

예 2.3. 메모리 집약적

- u7i-6tb.112xlarge (448 vCPU, 6,144GiB)

- u7i-8tb.112xlarge (448 vCPU, 6,144GiB)

- u7i-12tb.224xlarge (896 vCPU, 12,288GiB)

- u7in-16tb.224xlarge (896 vCPU, 16,384GiB)

- u7in-24tb.224xlarge (896 vCPU, 24,576GiB)

- u7in-32tb.224xlarge (896 vCPU, 32,768GiB)

- u7inh-32tb.480xlarge 1920 vCPU, 32,768GiB)

- x1.16xlarge (64 vCPU, 976GiB)

- x1.32xlarge(128 vCPU, 1952GiB)

- x1e.xlarge (4 vCPU, 122GiB)

- x1e.2xlarge (8 vCPU, 244GiB)

- x1e.4xlarge (16 vCPU, 488GiB)

- x1e.8xlarge(32 vCPU, 976GiB)

- x1e.16xlarge (64 vCPU, 1,952GiB)

- x1e.32xlarge(128 vCPU, 3,904GiB)

- x2idn.16xlarge (64 vCPU, 1024GiB)

- x2idn.24xlarge (96 vCPU, 1536GiB)

- x2idn.32xlarge(128 vCPU, 2048GiB)

- x2iedn.xlarge (4 vCPU, 128GiB)

- x2iedn.2xlarge (8 vCPU, 256GiB)

- x2iedn.4xlarge (16 vCPU, 512GiB)

- x2iedn.8xlarge(32 vCPU, 1024GiB)

- x2iedn.16xlarge (64 vCPU, 2048GiB)

- x2iedn.24xlarge (96 vCPU, 3072GiB)

- x2iedn.32xlarge(128 vCPU, 4096GiB)

- x2iezn.2xlarge (8 vCPU, 256GiB)

- x2iezn.4xlarge (16vCPU, 512GiB)

- x2iezn.6xlarge (24vCPU, 768GiB)

- x2iezn.8xlarge(32vCPU, 1,024GiB)

- x2iezn.12xlarge (48vCPU, 1,536GiB)

- x2idn.metal(128vCPU, 2,048GiB)

- x2iedn.metal (128vCPU, 4,096GiB)

- x2iezn.metal (48 vCPU, 1,536GiB)

예 2.4. 최적화된 메모리

- r4.xlarge (4 vCPU, 30.5GiB)

- r4.2xlarge (8 vCPU, 61GiB)

- r4.4xlarge (16 vCPU, 122GiB)

- r4.8xlarge(32 vCPU, 244GiB)

- r4.16xlarge (64 vCPU, 488GiB)

- r5.metal (96 Cryostat vCPU, 768GiB)

- r5.xlarge (4 vCPU, 32GiB)

- r5.2xlarge (8 vCPU, 64GiB)

- r5.4xlarge (16 vCPU, 128GiB)

- r5.8xlarge(32 vCPU, 256GiB)

- r5.12xlarge (48 vCPU, 384GiB)

- r5.16xlarge (64 vCPU, 512GiB)

- r5.24xlarge (96 vCPU, 768GiB)

- r5a.xlarge (4 vCPU, 32GiB)

- r5a.2xlarge (8 vCPU, 64GiB)

- r5a.4xlarge (16 vCPU, 128GiB)

- r5a.8xlarge(32 vCPU, 256GiB)

- r5a.12xlarge (48 vCPU, 384GiB)

- r5a.16xlarge (64 vCPU, 512GiB)

- r5a.24xlarge (96 vCPU, 768GiB)

- r5ad.xlarge (4 vCPU, 32GiB)

- r5ad.2xlarge (8 vCPU, 64GiB)

- r5ad.4xlarge (16 vCPU, 128GiB)

- r5ad.8xlarge(32 vCPU, 256GiB)

- r5ad.12xlarge (48 vCPU, 384GiB)

- r5ad.16xlarge (64 vCPU, 512GiB)

- r5ad.24xlarge (96 vCPU, 768GiB)

- r5d.metal (96 Cryostat vCPU, 768GiB)

- r5d.xlarge (4 vCPU, 32GiB)

- r5d.2xlarge (8 vCPU, 64GiB)

- r5d.4xlarge (16 vCPU, 128GiB)

- r5d.8xlarge(32 vCPU, 256GiB)

- r5d.12xlarge (48 vCPU, 384GiB)

- r5d.16xlarge (64 vCPU, 512GiB)

- r5d.24xlarge (96 vCPU, 768GiB)

- r5n.metal (96 vCPU, 768GiB)

- r5n.xlarge (4 vCPU, 32GiB)

- r5n.2xlarge (8 vCPU, 64GiB)

- r5n.4xlarge (16 vCPU, 128GiB)

- r5n.8xlarge(32 vCPU, 256GiB)

- r5n.12xlarge (48 vCPU, 384GiB)

- r5n.16xlarge (64 vCPU, 512GiB)

- r5n.24xlarge (96 vCPU, 768GiB)

- r5dn.metal (96 vCPU, 768GiB)

- r5dn.xlarge (4 vCPU, 32GiB)

- r5dn.2xlarge (8 vCPU, 64GiB)

- r5dn.4xlarge (16 vCPU, 128GiB)

- r5dn.8xlarge(32 vCPU, 256GiB)

- r5dn.12xlarge (48 vCPU, 384GiB)

- r5dn.16xlarge (64 vCPU, 512GiB)

- r5dn.24xlarge (96 vCPU, 768GiB)

- r6a.xlarge (4 vCPU, 32GiB)

- r6a.2xlarge (8 vCPU, 64GiB)

- r6a.4xlarge (16 vCPU, 128GiB)

- r6a.8xlarge(32 vCPU, 256GiB)

- r6a.12xlarge (48 vCPU, 384GiB)

- r6a.16xlarge (64 vCPU, 512GiB)

- r6a.24xlarge (96 vCPU, 768GiB)

- r6a.32xlarge(128 vCPU, 1,024GiB)

- r6a.48xlarge(192 vCPU, 1,536GiB)

- r6a.metal (192 vCPU, 1,536GiB)

- r6i.metal(128 vCPU, 1,024GiB)

- r6i.xlarge (4 vCPU, 32GiB)

- r6i.2xlarge (8 vCPU, 64GiB)

- r6i.4xlarge (16 vCPU, 128GiB)

- r6i.8xlarge(32 vCPU, 256GiB)

- r6i.12xlarge (48 vCPU, 384GiB)

- r6i.16xlarge (64 vCPU, 512GiB)

- r6i.24xlarge (96 vCPU, 768GiB)

- r6i.32xlarge(128 vCPU, 1,024GiB)

- r6id.xlarge (4 vCPU, 32GiB)

- r6id.2xlarge (8 vCPU, 64GiB)

- r6id.4xlarge (16 vCPU, 128GiB)

- r6id.8xlarge(32 vCPU, 256GiB)

- r6id.12xlarge (48 vCPU, 384GiB)

- r6id.16xlarge (64 vCPU, 512GiB)

- r6id.24xlarge (96 vCPU, 768GiB)

- r6id.32xlarge(128 vCPU, 1,024GiB)

- z1d.metal (48#159 vCPU, 384GiB)

- z1d.xlarge (4 vCPU, 32GiB)

- z1d.2xlarge (8 vCPU, 64GiB)

- z1d.3xlarge (12 vCPU, 96GiB)

- z1d.6xlarge (24 vCPU, 192GiB)

- z1d.12xlarge (48 vCPU, 384GiB)

- r7a.xlarge (4 vCPU, 32GiB)

- r7a.2xlarge (8 vCPU, 64GiB)

- r7a.4xlarge (16 vCPU, 128GiB)

- r7a.8xlarge(32 vCPU, 256GiB)

- r7a.12xlarge (48 vCPU, 384GiB)

- r7a.16xlarge (64 vCPU, 512GiB)

- r7a.24xlarge (96 vCPU, 768GiB)

- r7a.32xlarge(128 vCPU, 1024GiB)

- r7a.48xlarge(192 vCPU, 1536GiB)

- r7a.metal-48xl (192 vCPU, 1536GiB)

- r7i.xlarge (4 vCPU, 32GiB)

- r7i.2xlarge (8 vCPU, 64GiB)

- r7i.4xlarge (16 vCPU, 128GiB)

- r7i.8xlarge(32 vCPU, 256GiB)

- r7i.12xlarge (48 vCPU, 384GiB)

- r7i.16xlarge (64 vCPU, 512GiB)

- r7i.24xlarge (96 vCPU, 768GiB)

- r7i.metal-24xl (96 vCPU, 768GiB)

- r7iz.xlarge (4 vCPU, 32GiB)

- r7iz.2xlarge (8 vCPU, 64GiB)

- r7iz.4xlarge (16 vCPU, 128GiB)

- r7iz.8xlarge(32 vCPU, 256GiB)

- r7iz.12xlarge (48 vCPU, 384GiB)

- r7iz.16xlarge (64 vCPU, 512GiB)

- r7iz.32xlarge(128 vCPU, 1024GiB)

- r7iz.metal-16xl (64 vCPU, 512GiB)

- r7iz.metal-32xl (128 vCPU, 1024GiB)

이러한 인스턴스 유형은 48개의 물리적 코어에 96 논리 프로세서를 제공합니다. 두 개의 물리적 Intel 소켓이 있는 단일 서버에서 실행됩니다.

이 인스턴스 유형은 24개의 물리적 코어에 48개의 논리 프로세서를 제공합니다.

예 2.5. 가속화 컴퓨팅

- p3.2xlarge (8 vCPU, 61GiB)

- p3.8xlarge(32 vCPU, 244GiB)

- p3.16xlarge (64 vCPU, 488GiB)

- p3dn.24xlarge (96 vCPU, 768GiB)

- p4d.24xlarge (96 vCPU, 1,152GiB)

- p4de.24xlarge (96 vCPU, 1,152GiB)

- p5.48xlarge(192 vCPU, 2,048GiB)

- p5e.48xlarge(192 vCPU, 2,048GiB)

- p5en.48xlarge(192 vCPU, 2,048GiB)

- g4ad.xlarge (4 vCPU, 16GiB)

- g4ad.2xlarge (8 vCPU, 32GiB)

- g4ad.4xlarge (16 vCPU, 64GiB)

- g4ad.8xlarge(32 vCPU, 128GiB)

- g4ad.16xlarge (64 vCPU, 256GiB)

- g4dn.xlarge (4 vCPU, 16GiB)

- g4dn.2xlarge (8 vCPU, 32GiB)

- g4dn.4xlarge (16 vCPU, 64GiB)

- g4dn.8xlarge(32 vCPU, 128GiB)

- g4dn.12xlarge (48 vCPU, 192GiB)

- g4dn.16xlarge (64 vCPU, 256GiB)

- g4dn.metal (96 vCPU, 384GiB)

- g5.xlarge (4 vCPU, 16GiB)

- g5.2xlarge (8 vCPU, 32GiB)

- g5.4xlarge (16 vCPU, 64GiB)

- g5.8xlarge(32 vCPU, 128GiB)

- g5.16xlarge (64 vCPU, 256GiB)

- g5.12xlarge (48 vCPU, 192GiB)

- g5.24xlarge (96 vCPU, 384GiB)

- g5.48xlarge (192 vCPU, 768GiB)

- dl1.24xlarge (96 vCPU, 768GiB)

- g6.xlarge (4 vCPU, 16GiB)

- g6.2xlarge (8 vCPU, 32GiB)

- g6.4xlarge (16 vCPU, 64GiB)

- g6.8xlarge(32 vCPU, 128GiB)

- g6.12xlarge (48 vCPU, 192GiB)

- g6.16xlarge (64 vCPU, 256GiB)

- g6.24xlarge (96 vCPU, 384GiB)

- g6.48xlarge(192 vCPU, 768GiB)

- g6e.xlarge (4 vCPU, 32GiB)

- g6e.2xlarge (8 vCPU, 64GiB)

- g6e.4xlarge (16 vCPU, 128GiB)

- g6e.8xlarge(32 vCPU, 256GiB)

- g6e.12xlarge (48 vCPU, 384GiB)

- g6e.16xlarge (64 vCPU, 512GiB)

- g6e.24xlarge (96 vCPU, 768GiB)

- g6e.48xlarge(192 vCPU, 1,536GiB)

- gr6.4xlarge (16 vCPU, 128GiB)

- gr6.8xlarge(32 vCPU, 256GiB)

Intel 특정; Nvidia의 적용 대상이 아닙니다.

GPU 인스턴스 유형 소프트웨어 스택에 대한 지원은 AWS에서 제공합니다. AWS 서비스 할당량이 원하는 GPU 인스턴스 유형을 수용할 수 있는지 확인합니다.

예 2.6. 최적화된 컴퓨팅

- c5.metal (96 vCPU, 192GiB)

- c5.xlarge (4 vCPU, 8GiB)

- c5.2xlarge (8 vCPU, 16GiB)

- c5.4xlarge (16 vCPU, 32GiB)

- c5.9xlarge (36 vCPU, 72GiB)

- c5.12xlarge (48 vCPU, 96GiB)

- c5.18xlarge (72 vCPU, 144GiB)

- c5.24xlarge (96 vCPU, 192GiB)

- c5d.metal (96 vCPU, 192GiB)

- c5d.xlarge (4 vCPU, 8GiB)

- c5d.2xlarge (8 vCPU, 16GiB)

- c5d.4xlarge (16 vCPU, 32GiB)

- c5d.9xlarge (36 vCPU, 72GiB)

- c5d.12xlarge (48 vCPU, 96GiB)

- c5d.18xlarge (72 vCPU, 144GiB)

- c5d.24xlarge (96 vCPU, 192GiB)

- c5a.xlarge (4 vCPU, 8GiB)

- c5a.2xlarge (8 vCPU, 16GiB)

- c5a.4xlarge (16 vCPU, 32GiB)

- c5a.8xlarge(32 vCPU, 64GiB)

- c5a.12xlarge (48 vCPU, 96GiB)

- c5a.16xlarge (64 vCPU, 128GiB)

- c5a.24xlarge (96 vCPU, 192GiB)

- c5ad.xlarge (4 vCPU, 8GiB)

- c5ad.2xlarge (8 vCPU, 16GiB)

- c5ad.4xlarge (16 vCPU, 32GiB)

- c5ad.8xlarge(32 vCPU, 64GiB)

- c5ad.12xlarge (48 vCPU, 96GiB)

- c5ad.16xlarge (64 vCPU, 128GiB)

- c5ad.24xlarge (96 vCPU, 192GiB)

- c5n.metal (72 vCPU, 192GiB)

- c5n.xlarge (4 vCPU, 10.5GiB)

- c5n.2xlarge (8 vCPU, 21GiB)

- c5n.4xlarge (16 vCPU, 42GiB)

- c5n.9xlarge (36 vCPU, 96GiB)

- c5n.18xlarge (72 vCPU, 192GiB)

- c6a.xlarge (4 vCPU, 8GiB)

- c6a.2xlarge (8 vCPU, 16GiB)

- c6a.4xlarge (16 vCPU, 32GiB)

- c6a.8xlarge(32 vCPU, 64GiB)

- c6a.12xlarge (48 vCPU, 96GiB)

- c6a.16xlarge (64 vCPU, 128GiB)

- c6a.24xlarge (96 vCPU, 192GiB)

- c6a.32xlarge (128 vCPU, 256GiB)

- c6a.48xlarge (192 vCPU, 384GiB)

- c6a.metal (192 vCPU, 384GiB)

- c6i.metal (128 vCPU, 256GiB)

- c6i.xlarge (4 vCPU, 8GiB)

- c6i.2xlarge (8 vCPU, 16GiB)

- c6i.4xlarge (16 vCPU, 32GiB)

- c6i.8xlarge(32 vCPU, 64GiB)

- c6i.12xlarge (48 vCPU, 96GiB)

- c6i.16xlarge (64 vCPU, 128GiB)

- c6i.24xlarge (96 vCPU, 192GiB)

- c6i.32xlarge (128 vCPU, 256GiB)

- c6id.xlarge (4 vCPU, 8GiB)

- c6id.2xlarge (8 vCPU, 16GiB)

- c6id.4xlarge (16 vCPU, 32GiB)

- c6id.8xlarge(32 vCPU, 64GiB)

- c6id.12xlarge (48 vCPU, 96GiB)

- c6id.16xlarge (64 vCPU, 128GiB)

- c6id.24xlarge (96 vCPU, 192GiB)

- c6id.32xlarge(128 vCPU, 256GiB)

- c7a.xlarge (4 vCPU, 8GiB)

- c7a.2xlarge (8 vCPU, 16GiB)

- c7a.4xlarge (16 vCPU, 32GiB)

- c7a.8xlarge(32 vCPU, 64GiB)

- c7a.12xlarge (48 vCPU, 96GiB)

- c7a.16xlarge (64 vCPU, 128GiB)

- c7a.24xlarge (96 vCPU, 192GiB)

- c7a.32xlarge(128 vCPU, 256GiB)

- c7a.48xlarge(192 vCPU, 384GiB)

- c7a.metal-48xl (192 vCPU, 384GiB)

- c7i.xlarge (4 vCPU, 8GiB)

- c7i.2xlarge (8 vCPU, 16GiB)

- c7i.4xlarge (16 vCPU, 32GiB)

- c7i.8xlarge(32 vCPU, 64GiB)

- c7i.12xlarge (48 vCPU, 96GiB)

- c7i.16xlarge (64 vCPU, 128GiB)

- c7i.24xlarge (96 vCPU, 192GiB)

- c7i.48xlarge(192 vCPU, 384GiB)

- c7i-flex.xlarge (4 vCPU, 8GiB)

- c7i-flex.2xlarge (8 vCPU, 16GiB)

- c7i-flex.4xlarge (16 vCPU, 32GiB)

- c7i-flex.8xlarge(32 vCPU, 64GiB)

- c7i.metal-24xl (96 vCPU, 192GiB)

- c7i.metal-48xl (192 vCPU, 384GiB)

- hpc6a.48xlarge (96 vCPU, 384GiB)

- hpc6id.32xlarge (64 vCPU, 1024GiB)

- hpc7a.12xlarge (24 vCPU, 768GiB)

- hpc7a.24xlarge (48 vCPU, 768GiB)

- hpc7a.48xlarge (96 vCPU, 768GiB)

- hpc7a.96xlarge (192 vCPU, 768GiB)

예 2.7. 최적화된 스토리지

- i3.metal (72 Cryostat vCPU, 512GiB)

- i3.xlarge (4 vCPU, 30.5GiB)

- i3.2xlarge (8 vCPU, 61GiB)

- i3.4xlarge (16 vCPU, 122GiB)

- i3.8xlarge(32 vCPU, 244GiB)

- i3.16xlarge(64 vCPU, 488GiB)

- i3en.metal (96 vCPU, 768GiB)

- i3en.xlarge (4 vCPU, 32GiB)

- i3en.2xlarge (8 vCPU, 64GiB)

- i3en.3xlarge (12 vCPU, 96GiB)

- i3en.6xlarge (24 vCPU, 192GiB)

- i3en.12xlarge(48 vCPU, 384GiB)

- i3en.24xlarge (96 vCPU, 768GiB)

- i4i.xlarge (4 vCPU, 32GiB)

- i4i.2xlarge (8 vCPU, 64GiB)

- i4i.4xlarge (16 vCPU, 128GiB)

- i4i.8xlarge(32 vCPU, 256GiB)

- i4i.12xlarge (48 vCPU, 384GiB)

- i4i.16xlarge (64 vCPU, 512GiB)

- i4i.24xlarge (96 vCPU, 768GiB)

- i4i.32xlarge(128 vCPU, 1024GiB)

- i4i.metal(128 vCPU, 1024GiB)

이 인스턴스 유형은 36 개의 물리적 코어에서 72 개의 논리 프로세서를 제공합니다.

가상 인스턴스 유형은 ".metal" 인스턴스 유형보다 더 빨리 초기화됩니다.

예 2.8. 높은 메모리

- U-3tb1.56xlarge (224 vCPU, 3,072GiB)

- U-6tb1.56xlarge (224 vCPU, 6,144GiB)

- U-6tb1.112xlarge (448 vCPU, 6,144GiB)

- U-6tb1.metal (448 vCPU, 6,144GiB)

- U-9tb1.112xlarge (448 vCPU, 9,216GiB)

- U-9tb1.metal (448 vCPU, 9,216GiB)

- U-12tb1.112xlarge (448 vCPU, 12,288GiB)

- U-12tb1.metal (448 vCPU, 12,288GiB)

- U-18tb1.metal (448 vCPU, 18,432GiB)

- U-24tb1.metal (448 vCPU, 24,576GiB)

예 2.9. 고성능 컴퓨팅

- hpc6a.48xlarge (96 vCPU, 384GiB)

2.1.1.6. 비CCS 클러스터의 AWS 인스턴스 유형

OpenShift Dedicated는 AWS에서 다음과 같은 작업자 노드 유형 및 크기를 제공합니다.

예 2.10. 일반 목적

- m5.xlarge (4 vCPU, 16GiB)

- m5.2xlarge (8 vCPU, 32GiB)

- m5.4xlarge (16 vCPU, 64GiB)

예 2.11. 메모리 최적화

- r5.xlarge (4 vCPU, 32GiB)

- r5.2xlarge (8 vCPU, 64GiB)

- r5.4xlarge (16 vCPU, 128GiB)

예 2.12. 컴퓨팅 최적화

- c5.2xlarge (8 vCPU, 16GiB)

- c5.4xlarge (16 vCPU, 32GiB)

2.1.1.7. Google Cloud 인스턴스 유형

OpenShift Dedicated는 다른 클라우드 인스턴스 유형과 동일한 공통 CPU 및 메모리 용량을 가지도록 선택한 Google Cloud에서 다음과 같은 작업자 노드 유형과 크기를 제공합니다.

A2,a3,e2,c3 및 n4 인스턴스 유형은 CCS에서만 사용할 수 있습니다. c3 및 n4 인스턴스 유형은 OpenShift Dedicated 버전 4.18 이상에서 사용할 수 있습니다.

예 2.13. 일반 목적

- custom-4-16384 (4 vCPU, 16GiB)

- custom-8-32768 (8 vCPU, 32GiB)

- custom-16-65536 (16 vCPU, 64GiB)

- custom-32-131072(32 vCPU, 128GiB)

- custom-48-199608 (48 vCPU, 192GiB)

- custom-64-262144 (64 vCPU, 256GiB)

- custom-96-393216 (96 vCPU, 384GiB)

- c3-standard-192-metal (192 vCPU, 768GiB)

- e2-standard-4 (4 vCPU, 16GiB)

- n2-standard-4 (4 vCPU, 16GiB)

- e2-standard-8 (8 vCPU, 32GiB)

- n2-standard-8 (8 vCPU, 32GiB)

- e2-standard-16 (16 vCPU, 64GiB)

- n2-standard-16 (16 vCPU, 64GiB)

- e2-standard-32(32 vCPU, 128GiB)

- n2-standard-32(32 vCPU, 128GiB)

- n2-standard-48 (48 vCPU, 192GiB)

- n2-standard-64 (64 vCPU, 256GiB)

- n2-standard-80 (80 vCPU, 320GiB)

- n2-standard-96 (96 vCPU, 384GiB)

- n2-standard-128(128 vCPU, 512GiB)

- n4-standard-4 (4 vCPU, 16GiB)

- n4-standard-8 (8 vCPU, 32GiB)

- n4-standard-16 (16 vCPU, 64GiB)

- n4-standard-32(32 vCPU, 128GiB)

- n4-standard-48 (48 vCPU, 192GiB)

- n4-standard-64 (64 vCPU, 256GiB)

- n4-standard-80 (80 vCPU, 320 GiB)

예 2.14. 메모리 최적화

- custom-4-32768-ext (4 vCPU, 32GiB)

- custom-8-65536-ext (8 vCPU, 64GiB)

- custom-16-131072-ext (16 vCPU, 128GiB)

- c3-highmem-192-metal (192 vCPU, 1536GiB)

- e2-highmem-4 (4 vCPU, 32GiB)

- e2-highmem-8 (8 vCPU, 64GiB)

- e2-highmem-16 (16 vCPU, 128GiB)

- n2-highmem-4 ( vCPU, 32GiB)

- n2-highmem-8 (8 vCPU, 64GiB)

- n2-highmem-16 (16 vCPU, 128GiB)

- n2-highmem-32(32 vCPU, 256GiB)

- n2-highmem-48 (48 vCPU, 384GiB)

- n2-highmem-64 (64 vCPU, 512GiB)

- n2-highmem-80 (80 vCPU, 640GiB)

- n2-highmem-96 (96 vCPU, 768GiB)

- n2-highmem-128(128 vCPU, 864GiB)

- n4-highmem-4 (4 vCPU, 32GiB)

- n4-highmem-8 (8 vCPU, 64GiB)

- n4-highmem-16 (16 vCPU, 128GiB)

- n4-highmem-32(32 vCPU, 256GiB)

- n4-highmem-48 (48 vCPU, 384GiB)

- n4-highmem-64 (64 vCPU, 512GiB)

- n4-highmem-80 (80 vCPU, 640GiB)

예 2.15. 컴퓨팅 최적화

- custom-8-16384 (8 vCPU, 16GiB)

- custom-16-32768 (16 vCPU, 32GiB)

- custom-36-73728 (36 vCPU, 72GiB)

- custom-48-98304 (48 vCPU, 96GiB)

- custom-72-147456 (72 vCPU, 144GiB)

- custom-96-196608 (96 vCPU, 192GiB)

- c2-standard-4 (4 vCPU, 16GiB)

- c2-standard-8 (8 vCPU, 32GiB)

- c2-standard-16 (16 vCPU, 64GiB)

- c2-standard-30 (30 vCPU, 120GiB)

- c2-standard-60 (60 vCPU, 240GiB)

- c3-highcpu-192-metal (192 vCPU, 512GiB)

- e2-highcpu-8 (8 vCPU, 8GiB)

- e2-highcpu-16 (16 vCPU, 16GiB)

- e2-highcpu-32(32 vCPU, 32GiB)

- n2-highcpu-8 (8 vCPU, 8GiB)

- n2-highcpu-16 (16 vCPU, 16GiB)

- n2-highcpu-32(32 vCPU, 32GiB)

- n2-highcpu-48 (48 vCPU, 48GiB)

- n2-highcpu-64 (64 vCPU, 64GiB)

- n2-highcpu-80 (80 vCPU, 80GiB)

- n2-highcpu-96 (96 vCPU, 96GiB)

- n4-highcpu-4 (4 vCPU, 8GiB)

- n4-highcpu-8 (8 vCPU, 16GiB)

- n4-highcpu-16 (16 vCPU, 32GiB)

- n4-highcpu-32(32 vCPU, 64GiB)

- n4-highcpu-48 (48 vCPU, 96GiB)

- n4-highcpu-64 (64 vCPU, 128GiB)

- n4-highcpu-80 (80 vCPU, 160 GiB)

예 2.16. 가속화 컴퓨팅

- a2-highgpu-1g (12 vCPU, 85GiB)

- A2-highgpu-2g (24 vCPU,170 GiB)

- a2-highgpu-4g (48 vCPU, 340GiB)

- a2-highgpu-8g (96 vCPU, 680GiB)

- a2-megagpu-16g (96 vCPU, 1.33 TiB)

- a2-ultragpu-1g (12 vCPU,170 GiB)

- a2-ultragpu-2g (24 vCPU, 340GiB)

- a2-ultragpu-4g (48 vCPU, 680GiB)

- a2-ultragpu-8g (96 vCPU, 1360GiB)

- a3-highgpu-1g (26 vCPU, 234GiB)

- a3-highgpu-2g (52 vCPU, 468GiB)

- a3-highgpu-4g (104 vCPU, 936GiB)

- a3-highgpu-8g (208 vCPU, 1872GiB)

- a3-megagpu-8g (208 vCPU, 1872GiB)

- a3-edgegpu-8g (208 vCPU, 1872GiB)

2.1.1.8. 지역 및 가용성 영역

다음 리전은 OpenShift Container Platform 4에서 지원되며 OpenShift Dedicated에서 지원됩니다.

2.1.1.8.1. AWS 리전 및 가용성 영역

다음 AWS 리전은 OpenShift Container Platform 4에서 지원되며 OpenShift Dedicated에서 지원됩니다.

- AF-south-1 (Cape Town, AWS 옵트인 필요)

- ap-east-1 (홍콩, AWS 옵트인 필요)

- ap-northeast-1(도쿄)

- ap-northeast-2(서울)

- ap-northeast-3 (오사카)

- ap-south-1(뭄바이)

- ap-south-2 (Hyderabad, AWS opt-in 필요)

- ap-southeast-1(싱가포르)

- ap-southeast-2(시드니)

- ap-southeast-3 (Jakarta, AWS 옵트인 필요)

- ap-southeast-4 (Melbourne, AWS 옵트인 필요)

- ca-central-1 (캐나다 중부)

- eu-central-1(프랑크푸르트)

- eu-central-2(Zurich, AWS 옵트인 필요)

- eu-north-1(스톡홀름)

- eu-south-1 (Milan, AWS 옵트인 필요)

- eu-south-2 (스페인, AWS 옵트인 필요)

- eu-west-1(아일랜드)

- eu-west-2(런던)

- eu-west-3(파리)

- me-central-1(UAE, AWS 옵트인 필요)

- me-south-1 (브라린, AWS 옵트인 필요)

- sa-east-1(상파울루)

- us-east-1(버지니아 북부)

- us-east-2(오하이오)

- us-west-1(캘리포니아 북부)

- us-west-2(오레곤)

2.1.1.8.2. Google Cloud 리전 및 가용성 영역

현재 지원되는 Google Cloud 리전은 다음과 같습니다.

- asia-east1, Changhua County, 대만

- asia-east2, Hong Kong

- asia-northeast1,keystone, Japan

- asia-northeast2, 오사카, 일본

- asia-south1, 인도 뭄바이

- asia-south2, Delhi, India

- asia-southeast1, Jurong West, Singapore

- australia-southeast1, Sydney, Australia

- australia-southeast2, 멜버른, 호주

- europe-north1,#178ina, Finland

- europe-west1, St. Ghislain, 벨기에

- europe-west2, London, England, UK

- europe-west3, Frankfurt, Germany

- europe-west4, Eemshaven, Netherlands

- europe-west6, Zürich, Switzerland

- europe-west8, Milan, 이탈리아

- europe-west12, Turin, Italy

- europe-southwest1, Madrid, Spain

- northamerica-northeast1, 캐나다 퀘벡, 몬트리올

- southamerica-east1, Osasco (상파울루), 브라질

- southamerica-west1, Santiago, 칠레

- us-central1,pub Bluffs, Iowa, USA

- us-east1, Moncks Corner, South Carolina, USA

- us-east4, Ashburn, North Virginia, USA

- us-west1, The Dalles, Oregon, USA

- us-west2, Los Angeles, California, USA

- me-central1, Doha, 카타르

- me-central2, Dammam, Saudi Arabia

다중 AZ 클러스터는 가용성 영역이 3개 이상인 리전에만 배포할 수 있습니다( AWS 및 Google Cloud참조).

각 새로운 OpenShift Dedicated 클러스터는 단일 리전의 전용 VPC(Virtual Private Cloud) 내에 설치되며, 옵션은 단일 가용성 영역(Single-AZ) 또는 여러 가용 영역(Multi-AZ)에 배포할 수 있습니다. 이를 통해 클러스터 수준 네트워크 및 리소스 격리를 제공하고 VPN 연결 및 VPC 피어링과 같은 클라우드 공급자 VPC 설정을 활성화합니다. 영구 볼륨은 클라우드 블록 스토리지에서 지원하며, 프로비저닝되는 가용성 영역과 관련이 있습니다. 영구 볼륨은 스케줄링할 수 없는 Pod를 방지하기 위해 관련 Pod 리소스가 특정 가용성 영역에 할당될 때까지 볼륨에 바인딩되지 않습니다. 가용성 영역별 리소스는 동일한 가용성 영역의 리소스에서만 사용할 수 있습니다.

클러스터가 배포되면 리전과 단일 또는 다중 가용성 영역의 선택을 변경할 수 없습니다.

2.1.1.9. SLA(서비스 수준 계약)

서비스 자체에 대한 SLA는 Red Hat Enterprise Agreement 부록 4(Online Subscription Services)의 부록 4 에 정의되어 있습니다.

2.1.1.10. 제한된 지원 상태

클러스터가 제한된 지원 상태로 전환되면 Red Hat은 더 이상 클러스터를 사전 모니터링하지 않으며 SLA는 더 이상 적용되지 않으며 SLA에 대해 요청된 크레딧이 거부됩니다. 더 이상 제품 지원이 없다는 의미는 아닙니다. 위반 요소를 수정하는 경우 클러스터가 완전히 지원되는 상태로 돌아갈 수 있습니다. 그러나 다른 경우에는 클러스터를 삭제하고 다시 생성해야 할 수 있습니다.

클러스터는 다음 시나리오를 포함하여 여러 가지 이유로 제한된 지원 상태로 전환할 수 있습니다.

- 만료일 이전에 클러스터를 지원되는 버전으로 업그레이드하지 않는 경우

Red Hat은 라이프 사이클 종료일 이후 버전에 대해 런타임 또는 SLA를 보장하지 않습니다. 지속적인 지원을 받으려면 라이프 사이클 종료일 이전에 클러스터를 지원되는 버전으로 업그레이드합니다. 수명 종료일 이전에 클러스터를 업그레이드하지 않으면 지원되는 버전으로 업그레이드할 때까지 클러스터는 제한된 지원 상태로 전환됩니다.

Red Hat은 지원되지 않는 버전에서 지원되는 버전으로 업그레이드하기 위해 상업적으로 합리적인 지원을 제공합니다. 그러나 지원되는 업그레이드 경로를 더 이상 사용할 수 없는 경우 새 클러스터를 생성하고 워크로드를 마이그레이션해야 할 수 있습니다.

- 기본 OpenShift Dedicated 구성 요소 또는 Red Hat에서 설치 및 관리하는 기타 구성 요소를 제거하거나 교체하는 경우

- 클러스터 관리자 권한이 사용된 경우 Red Hat은 인프라 서비스, 서비스 가용성 또는 데이터 손실에 영향을 미치는 사용자를 포함하여 인증된 사용자의 작업에 대해 책임을 지지 않습니다. Red Hat이 이러한 작업을 감지하면 클러스터가 제한된 지원 상태로 전환될 수 있습니다. Red Hat은 상태 변경 사항을 사용자에게 알려주며 클러스터를 삭제하고 다시 생성해야 하는 수정 단계를 살펴보기 위해 작업을 되돌리거나 지원 케이스를 생성해야 합니다.

클러스터가 제한된 지원 상태로 전환되거나 추가 지원이 필요할 수 있는 특정 작업에 대해 질문이 있는 경우 지원 티켓을 작성하십시오.

2.1.1.11. 지원

OpenShift Dedicated에는 Red Hat 고객 포털을 사용하여 액세스할 수 있는 Red Hat 프리미엄 지원이 포함되어 있습니다.

OpenShift Dedicated에 대한 지원 관련 사항에 대한 자세한 내용은 지원 범위 페이지를 참조하십시오.

지원 응답 시간은 OpenShift Dedicated SLA 를 참조하십시오.

2.1.2. 로깅

OpenShift Dedicated는 AWS(Amazon Cloud) 또는 Google Cloud Logging(Google Cloud)에 대한 선택적 통합 로그 전달 기능을 제공합니다.

자세한 내용은 로그 수집 및 전달 정보를 참조하십시오.

2.1.2.1. 클러스터 감사 로깅

통합이 활성화된 경우 AWS의 Amazon Cloud 또는 Google Cloud Logging(Google Cloud에서)을 통해 클러스터 감사 로그를 사용할 수 있습니다. 통합이 활성화되지 않은 경우 지원 케이스를 열어 감사 로그를 요청할 수 있습니다. 감사 로그 요청은 21일을 초과하지 않는 날짜 및 시간 범위를 지정해야 합니다. 감사 로그를 요청할 때 고객은 감사 로그 크기가 일당 많은 GB임을 알고 있어야 합니다.

2.1.2.2. 애플리케이션 로깅

STDOUT 으로 전송된 애플리케이션 로그는 설치된 경우 클러스터 로깅 스택을 통해 AWS의 Amazon Cloud 또는 Google Cloud 로깅(Google Cloud의)으로 전달됩니다.

2.1.3. 모니터링

2.1.3.1. 클러스터 메트릭

OpenShift Dedicated 클러스터에는 CPU, 메모리 및 네트워크 기반 메트릭을 포함한 클러스터 모니터링을 위한 통합된 Prometheus/Grafana 스택이 제공됩니다. 웹 콘솔을 통해 액세스할 수 있으며 Grafana 대시보드를 통해 클러스터 수준 상태 및 용량/사용을 확인하는 데 사용할 수도 있습니다. 이러한 메트릭을 사용하면 OpenShift Dedicated 사용자가 제공하는 CPU 또는 메모리 메트릭을 기반으로 수평 Pod 자동 스케일링을 수행할 수 있습니다.

2.1.3.2. 클러스터 알림

클러스터 알림(서비스 로그라고도 함)은 클러스터의 상태, 상태 또는 성능에 대한 메시지입니다.

클러스터 알림은 Red Hat site Reliability Engineering(SRE)이 관리형 클러스터의 상태에 대해 귀하와 통신하는 기본 방법입니다. Red Hat SRE는 클러스터 알림을 사용하여 클러스터 문제를 해결하거나 방지하기 위해 작업을 수행하도록 요청할 수도 있습니다.

클러스터 소유자 및 관리자는 클러스터가 정상 상태로 유지되고 지원되는지 확인하기 위해 클러스터 알림을 정기적으로 검토하고 조치를 취해야 합니다.

클러스터의 클러스터 기록 탭에서 Red Hat Hybrid Cloud Console에서 클러스터 알림을 볼 수 있습니다. 기본적으로 클러스터 소유자만 이메일로 클러스터 알림을 수신합니다. 다른 사용자가 클러스터 알림 이메일을 수신해야 하는 경우 각 사용자를 클러스터에 대한 알림 연락처로 추가합니다.

2.1.4. 네트워킹

2.1.4.1. 애플리케이션 사용자 정의 도메인

OpenShift Dedicated 4.14부터 Custom Domain Operator는 더 이상 사용되지 않습니다. OpenShift Dedicated 4.14 이상에서 Ingress를 관리하려면 Ingress Operator를 사용합니다. OpenShift Dedicated 4.13 및 이전 버전에서는 기능이 변경되지 않습니다.

경로에 사용자 지정 호스트 이름을 사용하려면 정식 이름(CNAME) 레코드를 생성하여 DNS 공급자를 업데이트해야 합니다. CNAME 레코드는 OpenShift 정식 라우터 호스트 이름을 사용자 지정 도메인에 매핑해야 합니다. 경로를 생성한 후 OpenShift 표준 라우터 호스트 이름은 경로 세부 정보 페이지에 표시됩니다. 또는 지정된 호스트 이름의 모든 하위 도메인을 클러스터의 라우터에 라우팅하기 위해 와일드카드 CNAME 레코드를 한 번 생성할 수 있습니다.

2.1.4.2. 클러스터 서비스의 사용자 정의 도메인

사용자 정의 도메인 및 하위 도메인은 플랫폼 서비스 경로(예: API 또는 웹 콘솔 경로) 또는 기본 애플리케이션 경로에는 사용할 수 없습니다.

2.1.4.3. 도메인 검증 인증서

OpenShift Dedicated에는 클러스터의 내부 및 외부 서비스 모두에 필요한 TLS 보안 인증서가 포함되어 있습니다. 외부 경로의 경우 각 클러스터에 제공 및 설치된 두 개의 별도의 TLS 와일드카드 인증서가 있습니다. 하나는 웹 콘솔과 경로 기본 호스트 이름 및 API 끝점의 두 번째입니다. Let's Encrypt 는 인증서에 사용되는 인증 기관입니다. 클러스터 내의 경로(예: 내부 API 끝점 )는 클러스터의 기본 제공 인증 기관에서 서명한 TLS 인증서를 사용하며 TLS 인증서를 신뢰하기 위해 모든 Pod에서 CA 번들을 사용할 수 있어야 합니다.

2.1.4.4. 빌드에 대한 사용자 정의 인증 기관

OpenShift Dedicated에서는 이미지 레지스트리에서 이미지를 가져올 때 빌드에서 신뢰하는 사용자 정의 인증 기관 사용을 지원합니다.

2.1.4.5. 로드 밸런서

OpenShift Dedicated는 최대 5개의 로드 밸런서를 사용합니다.

- 클러스터 내부이고 내부 클러스터 통신을 위해 트래픽의 균형을 조정하는 데 사용되는 내부 컨트롤 플레인 로드 밸런서입니다.

- OpenShift Container Platform 및 Kubernetes API에 액세스하는 데 사용되는 외부 컨트롤 플레인 로드 밸런서입니다. 이 로드 밸런서는 Red Hat OpenShift Cluster Manager에서 비활성화할 수 있습니다. 이 로드 밸런서가 비활성화된 경우 Red Hat은 내부 제어 로드 밸런서를 가리키도록 API DNS를 재구성합니다.

- Red Hat의 클러스터 관리를 위해 예약된 Red Hat의 외부 컨트롤 플레인 로드 밸런서입니다. 액세스는 엄격하게 제어되며 허용 목록에 있는 bastion 호스트에서만 통신이 가능합니다.

-

기본 애플리케이션 로드 밸런서인 기본 라우터/ingress 로드 밸런서는 URL의

앱으로표시됩니다. 기본 로드 밸런서는 OpenShift Cluster Manager에서 인터넷을 통해 공개적으로 액세스할 수 있도록 구성하거나 기존 개인 연결을 통해 개인용으로만 액세스할 수 있습니다. 클러스터의 모든 애플리케이션 경로는 로깅 UI, 메트릭 API 및 레지스트리와 같은 클러스터 서비스를 포함하여 이 기본 라우터 로드 밸런서에 노출됩니다. -

선택 사항: 보조 애플리케이션 로드 밸런서인 두 번째 라우터/ingress 로드 밸런서는 URL에서

apps2로 표시됩니다. 보조 로드 밸런서는 OpenShift Cluster Manager에서 인터넷을 통해 공개적으로 액세스할 수 있도록 구성하거나 기존 개인 연결을 통해 비공개로만 액세스할 수 있도록 구성할 수 있습니다. 이 라우터 로드 밸런서에 대해 'Label match'가 구성된 경우 이 라벨과 일치하는 애플리케이션 경로만 이 라우터 로드 밸런서에 노출됩니다. 그렇지 않으면 모든 애플리케이션 경로도 이 라우터 로드 밸런서에 노출됩니다. - 선택 사항: HTTP/SNI 트래픽 또는 비표준 포트 사용과 같은 고급 인그레스 기능을 활성화하기 위해 OpenShift Dedicated에서 실행되는 서비스에 매핑될 수 있는 서비스의 로드 밸런서입니다. 이는 비CCS 클러스터의 경우 4 그룹에서 구입할 수 있거나 CCO(Customer Cloud Subscription) 클러스터 의 클라우드 공급자 콘솔을 통해 프로비저닝할 수 있지만 각 AWS 계정에는 각 클러스터 내에서 사용할 수 있는 Classic Load Balancer 수를 제한하는 할당량이 있습니다.

2.1.4.6. 네트워크 사용량

비CCS OpenShift Dedicated 클러스터의 경우 네트워크 사용량은 인바운드, VPC 피어링, VPN 및 AZ 트래픽 간의 데이터 전송을 기반으로 측정됩니다. 비CCS OpenShift Dedicated 기본 클러스터에서는 12TB의 네트워크 I/O가 제공됩니다. 추가 네트워크 I/O는 12TB 단위로 구매할 수 있습니다. CCS OpenShift Dedicated 클러스터의 경우 네트워크 사용량은 모니터링되지 않으며 클라우드 공급자가 직접 청구합니다.

2.1.4.7. 클러스터 인그레스

프로젝트 관리자는 IP 허용 목록을 통한 수신 제어를 포함하여 다양한 목적으로 경로 주석을 추가할 수 있습니다.

ovs-networkpolicy 플러그인을 활용하는 NetworkPolicy 오브젝트를 사용하여 Ingress 정책을 변경할 수도 있습니다. 이를 통해 동일한 클러스터와 동일한 네임스페이스에 있는 Pod를 포함하여 Pod 수준까지 수신 네트워크 정책을 완전히 제어할 수 있습니다.

모든 클러스터 인그레스 트래픽은 정의된 로드 밸런서를 통해 이루어집니다. 모든 노드에 대한 직접 액세스는 클라우드 구성에 의해 차단됩니다.

2.1.4.8. 클러스터 송신

EgressNetworkPolicy 오브젝트를 통한 Pod 송신 트래픽 제어를 사용하여 OpenShift Dedicated에서 아웃바운드 트래픽을 방지하거나 제한할 수 있습니다.

컨트롤 플레인 및 인프라 노드의 공용 아웃 바운드 트래픽이 필요하며 클러스터 이미지 보안 및 클러스터 모니터링을 유지 관리하는 데 필요합니다. 이를 위해서는 0.0.0.0/0 경로가 인터넷 게이트웨이에만 속해야 하며 이 범위를 개인 연결을 통해 라우팅할 수 없습니다.

OpenShift Dedicated 클러스터는 NAT 게이트웨이를 사용하여 클러스터를 나가는 모든 공용 아웃바운드 트래픽에 대한 공용 고정 IP를 제공합니다. 클러스터가 배포된 각 서브넷은 고유한 NAT 게이트웨이를 수신합니다. 여러 가용성 영역이 있는 AWS에 배포된 클러스터의 경우 클러스터 송신 트래픽에 대해 최대 3개의 고유한 고정 IP 주소가 존재할 수 있습니다. 가용성 영역 토폴로지에 관계없이 Google Cloud에 배포된 클러스터의 경우 작업자 노드 송신 트래픽에 대해 1개의 고정 IP 주소가 있습니다. 클러스터 내부 또는 공용 인터넷으로 이동하지 않는 모든 트래픽은 NAT 게이트웨이를 통과하지 않으며 트래픽이 시작된 노드에 소스 IP 주소가 속하게 됩니다. 노드 IP 주소는 동적이므로 개인 리소스에 액세스할 때 개별 IP 주소 허용 목록에 의존하지 않아야 합니다.

고객은 클러스터에서 Pod를 실행한 다음 외부 서비스를 쿼리하여 공용 고정 IP 주소를 확인할 수 있습니다. 예를 들면 다음과 같습니다.

oc run ip-lookup --image=busybox -i -t --restart=Never --rm -- /bin/sh -c "/bin/nslookup -type=a myip.opendns.com resolver1.opendns.com | grep -E 'Address: [0-9.]+'"

$ oc run ip-lookup --image=busybox -i -t --restart=Never --rm -- /bin/sh -c "/bin/nslookup -type=a myip.opendns.com resolver1.opendns.com | grep -E 'Address: [0-9.]+'"2.1.4.9. 클라우드 네트워크 구성

OpenShift Dedicated를 사용하면 여러 클라우드 공급자 관리형 기술을 통해 프라이빗 네트워크 연결을 구성할 수 있습니다.

- VPN 연결

- AWS VPC 피어링

- AWS Transit Gateway

- AWS Direct Connect

- Google Cloud VPC 네트워크 피어링

- Google Cloud Classic VPN

- Google Cloud HA VPN

Red Hat SREs는 사설 네트워크 연결을 모니터링하지 않습니다. 이러한 연결을 모니터링하는 것은 고객의 책임이 있습니다.

2.1.4.10. DNS 전달

프라이빗 클라우드 네트워크 구성이 있는 OpenShift Dedicated 클러스터의 경우 고객은 명시적으로 제공된 도메인에 대해 쿼리해야 하는 프라이빗 연결에서 사용할 수 있는 내부 DNS 서버를 지정할 수 있습니다.

2.1.4.11. 네트워크 확인

네트워크 확인 검사는 기존 VPC(Virtual Private Cloud)에 OpenShift Dedicated 클러스터를 배포하거나 클러스터에 새로 추가된 서브넷을 사용하여 추가 머신 풀을 생성할 때 자동으로 실행됩니다. 검사를 통해 네트워크 구성을 확인하고 오류를 강조 표시하여 배포 전에 구성 문제를 해결할 수 있습니다.

네트워크 확인 검사를 수동으로 실행하여 기존 클러스터의 구성을 확인할 수도 있습니다.

2.1.5. 스토리지

2.1.5.1. encrypted-at-rest OS/node 스토리지

컨트롤 플레인 노드는 encrypted-at-rest-EBS 스토리지를 사용합니다.

2.1.5.2. encrypted-at-rest PV

PV(영구 볼륨)에 사용되는 EBS 볼륨은 기본적으로 암호화되어 있습니다.

2.1.5.3. 블록 스토리지(RWO)

PV(영구 볼륨)는 RWO(ReadWriteOnce) 액세스 모드를 사용하는 AWS EBS 및 Google Cloud 영구 디스크 블록 스토리지에서 지원합니다. 비CCS OpenShift Dedicated 기본 클러스터에서 PV에 대해 100GB의 블록 스토리지가 제공되며 애플리케이션 요청에 따라 동적으로 프로비저닝 및 재활용됩니다. 추가 영구 스토리지는 500GB 단위로 구매할 수 있습니다.

PV는 한 번에 단일 노드에만 연결할 수 있으며 프로비저닝된 가용성 영역에 고유하지만 가용성 영역의 모든 노드에 연결할 수 있습니다.

각 클라우드 공급자에는 단일 노드에 연결할 수 있는 PV 수에 대한 자체 제한이 있습니다. 자세한 내용은 AWS 인스턴스 유형 제한 또는 Google Cloud 사용자 지정 머신 유형을 참조하십시오.

2.1.6. 플랫폼

2.1.6.1. 클러스터 백업 정책

고객은 애플리케이션 및 애플리케이션 데이터에 대한 백업 계획을 가지고 있어야 합니다.

애플리케이션 및 애플리케이션 데이터 백업은 OpenShift Dedicated 서비스의 일부가 아닙니다. 각 OpenShift Dedicated 클러스터의 모든 Kubernetes 오브젝트는 클러스터가 작동하지 않는 경우 신속하게 복구할 수 있도록 백업됩니다.

백업은 클러스터와 동일한 계정의 보안 오브젝트 스토리지(Multi-AZ) 버킷에 저장됩니다. Red Hat Enterprise Linux CoreOS는 OpenShift Container Platform 클러스터에서 완전히 관리되고 상태 저장 데이터를 노드의 루트 볼륨에 저장하지 않으므로 노드 루트 볼륨이 백업되지 않습니다.

다음 표에서는 백업 빈도를 보여 줍니다.The following table shows the frequency of backups:

| Component | 스냅샷 빈도 | 보존 | 참고 |

|---|---|---|---|

| 전체 오브젝트 저장소 백업 | 매일 0100 UTC | 7일 | 이는 모든 Kubernetes 오브젝트의 전체 백업입니다. 이 백업 일정에는 PV(영구 볼륨)가 백업되지 않습니다. |

| 전체 오브젝트 저장소 백업 | 매주 월요일 0200 UTC | 30일 | 이는 모든 Kubernetes 오브젝트의 전체 백업입니다. 이 백업 일정에는 PV가 백업되지 않습니다. |

| 전체 오브젝트 저장소 백업 | 시간 전 17분 후 | 24시간 | 이는 모든 Kubernetes 오브젝트의 전체 백업입니다. 이 백업 일정에는 PV가 백업되지 않습니다. |

2.1.6.2. 자동 확장

노드 자동 스케일링은 OpenShift Dedicated에서 사용할 수 있습니다. 클러스터에서 노드 자동 스케일링에 대한 자세한 내용은 클러스터에서 노드 자동 스케일링 정보를 참조하십시오.

2.1.6.3. 데몬 세트

고객은 OpenShift Dedicated에서 DaemonSet을 생성하고 실행할 수 있습니다. DaemonSet을 작업자 노드에서만 실행되도록 제한하려면 다음 nodeSelector를 사용합니다.

...

spec:

nodeSelector:

role: worker

...

...

spec:

nodeSelector:

role: worker

...2.1.6.4. 여러 가용성 영역

여러 가용성 영역 클러스터에서 컨트롤 노드는 가용성 영역에 분산되며 각 가용성 영역에는 3개 이상의 작업자 노드가 필요합니다.

2.1.6.5. 노드 라벨

사용자 정의 노드 레이블은 노드 생성 중에 Red Hat에서 생성하며 현재 OpenShift Dedicated 클러스터에서 변경할 수 없습니다.

2.1.6.6. OpenShift version

OpenShift Dedicated는 서비스로 실행되며 최신 OpenShift Container Platform 버전으로 최신 상태로 유지됩니다.

2.1.6.7. 업그레이드

업그레이드 정책 및 절차에 대한 자세한 내용은 OpenShift Dedicated 라이프 사이클 을 참조하십시오.

2.1.6.8. Windows 컨테이너

현재 OpenShift Dedicated에서는 Windows 컨테이너를 사용할 수 없습니다.

2.1.6.9. 컨테이너 엔진

OpenShift Dedicated는 OpenShift 4에서 실행되며 사용 가능한 유일한 컨테이너 엔진으로 CRI-O 를 사용합니다.

2.1.6.10. 운영 체제

OpenShift Dedicated는 OpenShift 4에서 실행되며 모든 컨트롤 플레인 및 작업자 노드의 운영 체제로 Red Hat Enterprise Linux CoreOS를 사용합니다.

2.1.6.11. Red Hat Operator 지원

Red Hat 워크로드는 일반적으로 Operator Hub를 통해 제공되는 Red Hat 제공 Operator를 참조합니다. Red Hat 워크로드는 Red Hat SRE 팀에서 관리하지 않으며 작업자 노드에 배포해야 합니다. 이러한 Operator에는 추가 Red Hat 서브스크립션이 필요할 수 있으며 추가 클라우드 인프라 비용이 발생할 수 있습니다. Red Hat 제공 Operator의 예는 다음과 같습니다.

- Red Hat Quay

- Red Hat Advanced Cluster Management

- Red Hat Advanced Cluster Security

- Red Hat OpenShift Service Mesh

- OpenShift Serverless

- Red Hat OpenShift Logging

- Red Hat OpenShift Pipelines

2.1.6.12. Kubernetes Operator 지원

소프트웨어 카탈로그 마켓플레이스에 나열된 모든 Operator를 설치할 수 있어야 합니다. Red Hat Operator를 포함하여 소프트웨어 카탈로그에서 설치된 Operator는 OpenShift Dedicated 서비스의 일부로 SRE를 관리하지 않습니다. 지정된 Operator의 지원 가능성에 대한 자세한 내용은 Red Hat 고객 포털 을 참조하십시오.

2.1.7. 보안

이 섹션에서는 OpenShift Dedicated 보안을 위한 서비스 정의에 대한 정보를 제공합니다.

2.1.7.1. 인증 공급자

클러스터의 인증은 Red Hat OpenShift Cluster Manager 클러스터 생성 프로세스의 일부로 구성됩니다. OpenShift는 ID 공급자가 아니며 클러스터에 대한 모든 액세스는 고객이 통합 솔루션의 일부로 관리해야 합니다. 동시에 프로비저닝된 여러 ID 공급자의 프로비저닝이 지원됩니다. 지원되는 ID 공급자는 다음과 같습니다.

- GitHub 또는 GitHub Enterprise OAuth

- GitLab OAuth

- Google OAuth

- LDAP

- OpenID 연결

2.1.7.2. 권한이 있는 컨테이너

권한 있는 컨테이너는 OpenShift Dedicated에서 기본적으로 사용할 수 없습니다. anyuid 및 nonroot 보안 컨텍스트 제약 조건은 dedicated-admins 그룹의 멤버에 사용할 수 있으며 많은 사용 사례를 처리해야 합니다. 권한이 있는 컨테이너는 cluster-admin 사용자만 사용할 수 있습니다.

2.1.7.3. 고객 관리자 사용자

OpenShift Dedicated는 일반 사용자 외에도 dedicated-admin 이라는 OpenShift Dedicated 전용 그룹에 대한 액세스를 제공합니다. dedicated-admin 그룹의 멤버인 클러스터의 모든 사용자:

- 클러스터의 모든 고객이 생성한 프로젝트에 대한 관리자 액세스 권한이 있어야 합니다.

- 클러스터의 리소스 할당량 및 제한을 관리할 수 있습니다.

-

NetworkPolicy오브젝트를 추가하고 관리할 수 있습니다. - 스케줄러 정보를 포함하여 클러스터의 특정 노드 및 PV에 대한 정보를 볼 수 있습니다.

-

클러스터의 예약된

dedicated-admin프로젝트에 액세스할 수 있으므로 승격된 권한으로 서비스 계정을 생성할 수 있으며 클러스터의 기본 제한 및 할당량을 업데이트할 수 있습니다. -

소프트웨어 카탈로그에서 Operator를 설치할 수 있습니다(

*모든*.operators.coreos.comAPI 그룹의 동사).

2.1.7.4. 클러스터 관리 역할

CCO(Customer Cloud Subscription)를 사용하는 OpenShift Dedicated의 관리자는 cluster-admin 역할에 액세스할 수 있습니다. cluster-admin 역할을 사용하여 계정에 로그인하는 동안 사용자는 대부분 무제한으로 클러스터를 제어하고 구성할 수 있습니다. 클러스터 불안정을 방지하기 위해 Webhook로 차단되거나 OpenShift Cluster Manager에서 관리되고 클러스터 내 변경 사항을 덮어쓰기 위해 Webhook로 차단되는 몇 가지 구성이 있습니다.

2.1.7.5. 프로젝트 셀프 서비스

기본적으로 모든 사용자는 프로젝트를 생성, 업데이트 및 삭제할 수 있습니다. dedicated-admin 그룹의 멤버가 인증된 사용자로부터 self-provisioner 역할을 제거하는 경우 이를 제한할 수 있습니다.

oc adm policy remove-cluster-role-from-group self-provisioner system:authenticated:oauth

$ oc adm policy remove-cluster-role-from-group self-provisioner system:authenticated:oauth다음을 적용하여 제한 사항을 되돌릴 수 있습니다.

oc adm policy add-cluster-role-to-group self-provisioner system:authenticated:oauth

$ oc adm policy add-cluster-role-to-group self-provisioner system:authenticated:oauth2.1.7.6. 규정 준수

최신 규정 준수 정보는 OpenShift Dedicated의 프로세스 및 보안 이해에서 OpenShift Dedicated 테이블의 보안 및 제어 인증을 참조하십시오.

2.1.7.7. 네트워크 보안

각 OpenShift Dedicated 클러스터는 방화벽 규칙(AWS Security Groups 또는 Google Cloud Compute Engine 방화벽 규칙)을 사용하여 클라우드 인프라 수준에서 보안 네트워크 구성으로 보호됩니다. AWS의 OpenShift Dedicated 고객도 AWS Shield Standard 를 사용하여 DDoS 공격으로부터 보호됩니다. 마찬가지로 Google Cloud의 OpenShift Dedicated에서 사용하는 모든 Google Cloud 로드 밸런서 및 공용 IP 주소는 Google Cloud Armor Standard 를 사용하여 DDoS 공격으로부터 보호됩니다.

2.1.7.8. etcd 암호화

OpenShift Dedicated에서 컨트롤 플레인 스토리지는 기본적으로 암호화되어 etcd 볼륨의 암호화가 포함됩니다. 이 스토리지 수준 암호화는 클라우드 공급자의 스토리지 계층을 통해 제공됩니다.

etcd의 키 값을 암호화하지만 키는 암호화하지 않는 etcd 암호화를 활성화할 수도 있습니다. etcd 암호화를 활성화하면 다음 Kubernetes API 서버 및 OpenShift API 서버 리소스가 암호화됩니다.

- 보안

- 구성 맵

- 라우트

- OAuth 액세스 토큰

- OAuth 승인 토큰

etcd 암호화 기능은 기본적으로 활성화되어 있지 않으며 클러스터 설치 시에만 활성화할 수 있습니다. etcd 암호화가 활성화된 상태에서도 etcd 키 값은 컨트롤 플레인 노드 또는 cluster-admin 권한에 액세스할 수 있는 모든 사용자가 액세스할 수 있습니다.

etcd의 키 값에 etcd 암호화를 활성화하면 약 20%의 성능 오버헤드가 발생합니다. 오버헤드는 etcd 볼륨을 암호화하는 기본 컨트롤 플레인 스토리지 암호화 외에도 이 두 번째 암호화 계층이 도입된 결과입니다. 특히 사용 사례에 필요한 경우에만 etcd 암호화를 활성화하는 것이 좋습니다.

2.2. 책임 할당 매트릭스

OpenShift Dedicated 관리형 서비스에 대한 Red Hat, 클라우드 공급자 및 고객 책임을 이해하십시오.

2.2.1. OpenShift Dedicated에 대한 설명

Red Hat은 OpenShift Dedicated 서비스를 관리하는 반면 고객은 특정 측면과 관련하여 책임을 공유합니다. OpenShift Dedicated 서비스는 Red Hat 또는 고객 소유 클라우드 서비스 공급자 계정에서 생성된 퍼블릭 클라우드 리소스에서 호스팅되는 원격으로 액세스할 수 있으며 Red Hat이 소유한 기본 플랫폼 및 데이터 보안이 있습니다.

클러스터에서 cluster-admin 역할이 활성화된 경우 Red Hat Enterprise Agreement 부록 4(Online Subscription Services) 의 역할 및 제외 노트를 참조하십시오.

| 리소스 | 사고 및 운영 관리 | 변경 관리 | 액세스 및 ID 권한 부여 | 보안 및 규정 준수 | 재해 복구 |

|---|---|---|---|---|---|

| 고객 데이터 | 고객 | 고객 | 고객 | 고객 | 고객 |

| 고객 애플리케이션 | 고객 | 고객 | 고객 | 고객 | 고객 |

| 개발자 서비스 | 고객 | 고객 | 고객 | 고객 | 고객 |

| 플랫폼 모니터링 | Red Hat | Red Hat | Red Hat | Red Hat | Red Hat |

| 로깅 | Red Hat | shared | shared | shared | Red Hat |

| 애플리케이션 네트워킹 | shared | shared | shared | Red Hat | Red Hat |

| 클러스터 네트워킹 | Red Hat | shared | shared | Red Hat | Red Hat |

| 가상 네트워킹 | shared | shared | shared | shared | shared |

| 컨트롤 플레인 및 인프라 노드 | Red Hat | Red Hat | Red Hat | Red Hat | Red Hat |

| 작업자 노드 | Red Hat | Red Hat | Red Hat | Red Hat | Red Hat |

| 클러스터 버전 | Red Hat | shared | Red Hat | Red Hat | Red Hat |

| 용량 관리 | Red Hat | shared | Red Hat | Red Hat | Red Hat |

| 가상 스토리지 | Red Hat 및 클라우드 공급자 | Red Hat 및 클라우드 공급자 | Red Hat 및 클라우드 공급자 | Red Hat 및 클라우드 공급자 | Red Hat 및 클라우드 공급자 |

| 물리적 인프라 및 보안 | 클라우드 공급자 | 클라우드 공급자 | 클라우드 공급자 | 클라우드 공급자 | 클라우드 공급자 |

2.2.3. 데이터 및 애플리케이션에 대한 고객 책임이

고객은 OpenShift Dedicated에 배포하는 애플리케이션, 워크로드 및 데이터를 담당합니다. 그러나 Red Hat은 고객이 플랫폼에서 데이터 및 애플리케이션을 관리하는 데 도움이 되는 다양한 툴을 제공합니다.

| 리소스 | Red Hat 역할 | 고객 역할 |

|---|---|---|

| 고객 데이터 |

| 플랫폼에 저장된 모든 고객 데이터와 고객 애플리케이션이 이 데이터를 소비하고 노출하는 방식에 대한 책임을 유지합니다. |

| 고객 애플리케이션 |

|

|

2.3. OpenShift Dedicated의 프로세스 및 보안 이해

2.3.1. 클러스터 알림 검토 및 작업

클러스터 알림(서비스 로그라고도 함)은 클러스터의 상태, 상태 또는 성능에 대한 메시지입니다.

클러스터 알림은 Red Hat site Reliability Engineering(SRE)이 관리형 클러스터의 상태에 대해 귀하와 통신하는 기본 방법입니다. Red Hat SRE는 클러스터 알림을 사용하여 클러스터 문제를 해결하거나 방지하기 위해 작업을 수행하도록 요청할 수도 있습니다.

클러스터 소유자 및 관리자는 클러스터가 정상 상태로 유지되고 지원되는지 확인하기 위해 클러스터 알림을 정기적으로 검토하고 조치를 취해야 합니다.

클러스터의 클러스터 기록 탭에서 Red Hat Hybrid Cloud Console에서 클러스터 알림을 볼 수 있습니다. 기본적으로 클러스터 소유자만 이메일로 클러스터 알림을 수신합니다. 다른 사용자가 클러스터 알림 이메일을 수신해야 하는 경우 각 사용자를 클러스터에 대한 알림 연락처로 추가합니다.

2.3.1.1. 클러스터 알림 정책

클러스터 알림은 클러스터의 상태와 영향을 미치는 높은 영향을 미치는 이벤트에 대한 정보를 유지하도록 설계되었습니다.

대부분의 클러스터 알림은 자동으로 생성되고 전송되어 즉시 문제에 대한 정보 또는 클러스터 상태에 대한 중요한 변경 사항을 확인할 수 있습니다.

특정 상황에서 Red Hat 사이트 안정성 엔지니어링(SRE)은 클러스터 알림을 생성하고 전송하여 복잡한 문제에 대한 추가 컨텍스트 및 지침을 제공합니다.

영향을 받지 않는 이벤트, 위험이 낮은 보안 업데이트, 일상적인 운영 및 유지 관리 또는 Red Hat SRE가 신속하게 해결하는 일시적인 문제에 대해서는 클러스터 알림이 전송되지 않습니다.

Red Hat 서비스는 다음과 같은 경우 자동으로 알림을 보냅니다.

- 원격 상태 모니터링 또는 환경 확인 검사에서는 작업자 노드에 디스크 공간이 부족한 경우와 같이 클러스터에서 문제를 감지합니다.

- 예를 들어 예정된 유지 관리 또는 업그레이드가 시작되는 경우 심각한 클러스터 라이프 사이클 이벤트가 발생하거나 클러스터 작업이 이벤트의 영향을 받지만 고객의 개입은 필요하지 않습니다.

- 예를 들어 클러스터 소유권 또는 관리 제어가 한 사용자에서 다른 사용자로 전송되는 경우와 같이 중요한 클러스터 관리 변경이 발생합니다.

- 예를 들어 Red Hat이 클러스터에서 서브스크립션 조건 또는 기능을 업데이트할 때 클러스터 서브스크립션이 변경 또는 업데이트됩니다.

SRE는 다음과 같은 경우 알림을 생성하고 보냅니다.

- 사고로 인해 클러스터의 가용성 또는 성능에 영향을 미치는 성능 저하 또는 중단이 발생합니다(예: 클라우드 공급자의 경우 지역 중단). SRE는 사고 해결 진행 상황을 알려주기 위해 후속 알림을 보냅니다.

- 클러스터에서 보안 취약점, 보안 위반 또는 비정상적인 활동이 감지됩니다.

- Red Hat은 변경 사항이 생성 중이거나 클러스터 불안정성을 초래할 수 있음을 감지합니다.

- Red Hat은 워크로드가 클러스터에서 성능 저하 또는 불안정성을 초래하고 있음을 감지합니다.

2.3.2. 사고 및 운영 관리

이 문서에서는 OpenShift Dedicated 관리 서비스에 대한 Red Hat 책임을 자세히 설명합니다. 클라우드 공급자는 클라우드 공급자가 제공하는 서비스를 실행하는 하드웨어 인프라를 보호할 책임이 있습니다. 고객은 고객 애플리케이션 데이터의 사고 및 운영 관리 및 고객이 클러스터 네트워크 또는 가상 네트워크에 대해 구성한 사용자 지정 네트워킹을 담당합니다.

2.3.2.1. 플랫폼 모니터링

Red Hat 사이트 안정성 엔지니어(SRE)는 모든 OpenShift Dedicated 클러스터 구성 요소, SRE 서비스 및 기본 클라우드 공급자 계정에 대해 중앙 집중식 모니터링 및 경고 시스템을 유지 관리합니다. 플랫폼 감사 로그는 중앙 집중식 SIEM(보안 정보 및 이벤트 모니터링) 시스템으로 안전하게 전달됩니다. 여기서 SRE 팀에 구성된 경고를 트리거할 수 있으며 수동 검토도 적용됩니다. 감사 로그는 1년 동안 SIEM에 보관됩니다. 클러스터가 삭제될 때 지정된 클러스터의 감사 로그는 삭제되지 않습니다.

2.3.2.2. 사고 관리

사고는 하나 이상의 Red Hat 서비스의 성능 저하 또는 중단을 초래하는 이벤트입니다.

고객 또는 CEE(Customer Experience and Engagement) 멤버, 중앙 집중식 모니터링 및 경고 시스템에 의해 직접 또는 SRE 팀의 구성원에 의해 직접 사고가 발생할 수 있습니다.

서비스 및 고객에 미치는 영향에 따라 이 문제는 심각도 별로 분류됩니다.

Red Hat은 새로운 사고를 관리할 때 다음과 같은 일반적인 워크플로를 사용합니다.

- SRE 첫 번째 대응자가 새로운 사고에 대해 경고하고 초기 조사를 시작합니다.

- 초기 조사 후 이 사고에는 복구 노력을 조정하는 사고 주도가 할당됩니다.

- 사고 리더는 관련 알림 또는 지원 케이스 업데이트를 포함하여 복구 관련 모든 통신 및 조정을 관리합니다.

- 문제가 해결되면 사고에 대한 간략한 요약이 고객의 지원 티켓에 제공됩니다. 이 요약은 고객이 사고와 해결 방법을 더 자세히 이해하는 데 도움이 됩니다.

고객이 지원 티켓에 제공되는 내용 외에 자세한 정보가 필요한 경우 다음 워크플로우를 요청할 수 있습니다.

- 고객은 사고 해결 후 5일 이내에 추가 정보를 요청해야 합니다.

- 사고의 심각도에 따라 Red Hat은 근본 원인 요약 또는 지원 티켓에서 RCA(root cause analysis)를 고객에게 제공할 수 있습니다. 추가 정보는 근본 원인 요약 및 사고 해결의 근본 원인 분석을 위해 30일 이내에 제공됩니다.

Red Hat은 지원 케이스를 통해 발생하는 고객 사고도 지원합니다. Red Hat은 다음을 포함하되 이에 국한되지 않는 활동을 지원할 수 있습니다.

- 가상 컴퓨팅 격리를 포함한 포렌식 수집

- 컴퓨팅 이미지 컬렉션 안내

- 수집된 감사 로그 제공

2.3.2.3. 백업 및 복구

모든 OpenShift Dedicated 클러스터는 클라우드 공급자 스냅샷을 사용하여 백업됩니다. 특히 PV(영구 볼륨)에 저장된 고객 데이터는 포함되지 않습니다. 모든 스냅샷은 적절한 클라우드 공급자 스냅샷 API를 사용하여 수행되며 클러스터와 동일한 계정의 보안 오브젝트 스토리지 버킷(AWS의 S3 및 Google Cloud의 GCS)에 업로드됩니다.

| Component | 스냅샷 빈도 | 보존 | 참고 |

|---|---|---|---|

| 전체 오브젝트 저장소 백업 | daily | 7일 | 이는 etcd와 같은 모든 Kubernetes 오브젝트의 전체 백업입니다. 이 백업 일정에는 PV가 백업되지 않습니다. |

| weekly | 30일 | ||

| 전체 오브젝트 저장소 백업 | hourly | 24시간 | 이는 etcd와 같은 모든 Kubernetes 오브젝트의 전체 백업입니다. 이 백업 일정에는 PV가 백업되지 않습니다. |

| 노드 루트 볼륨 | Never | 해당 없음 | 노드는 단기적으로 간주됩니다. 중요한 것은 노드의 루트 볼륨에 저장해야 합니다. |

- Red Hat은 RRPO(복구 지점 목표) 또는 복구 시간 목표(RTO)를 커밋하지 않습니다.

- 고객은 데이터의 정기적인 백업을 수행할 책임이 있습니다.

- 고객은 Kubernetes 모범 사례를 따르는 워크로드와 함께 다중 AZ 클러스터를 배포하여 리전 내에서 고가용성을 보장해야 합니다.

- 전체 클라우드 리전을 사용할 수 없는 경우 고객은 다른 지역에 새 클러스터를 설치하고 백업 데이터를 사용하여 앱을 복원해야 합니다.

2.3.2.4. 클러스터 용량

클러스터 용량 평가 및 관리는 Red Hat과 고객 간에 공유되는 책임이 있습니다. Red Hat SRE는 클러스터의 모든 컨트롤 플레인 및 인프라 노드의 용량을 담당합니다.

Red Hat SRE는 업그레이드 중에 클러스터 용량을 평가하고 클러스터 알림에 대응합니다. 클러스터 업그레이드 용량의 영향은 업그레이드 테스트 프로세스의 일부로 평가되어 클러스터에 새로운 추가 기능의 영향을 받지 않도록 합니다. 클러스터 업그레이드 중에 업그레이드 프로세스 중에 총 클러스터 용량이 유지되도록 추가 작업자 노드가 추가됩니다.

SRE 직원의 용량 평가는 특정 기간 동안 사용량 임계값이 초과된 경우 클러스터의 경고에 따라 수행됩니다. 이러한 경고는 또한 고객에게 알림을 초래할 수 있습니다.

2.3.3. 변경 관리

이 섹션에서는 클러스터 및 구성 변경 사항, 패치 및 릴리스를 관리하는 방법에 대해 설명합니다.

2.3.3.1. 고객 시작 변경

클러스터 배포, 작업자 노드 확장 또는 클러스터 삭제와 같은 셀프 서비스 기능을 사용하여 변경을 시작할 수 있습니다.

변경 내역은 OpenShift Cluster Manager 개요 탭 의 클러스터 기록 섹션에 캡처되며 사용자가 볼 수 있습니다. 변경 기록에는 다음 변경 사항의 로그가 포함되어 있지만 이에 국한되지는 않습니다.

- ID 공급자 추가 또는 제거

-

dedicated-admins그룹에 사용자 추가 또는 제거 - 클러스터 컴퓨팅 노드 확장

- 클러스터 로드 밸런서 확장

- 클러스터 영구 스토리지 스케일링

- 클러스터 업그레이드

다음 구성 요소에 대해 OpenShift Cluster Manager의 변경을 방지하여 유지 관리 제외를 구현할 수 있습니다.

- 클러스터 삭제

- ID 공급자 추가, 수정 또는 제거

- 승격된 그룹에서 사용자 추가, 수정 또는 제거

- 애드온 설치 또는 제거

- 클러스터 네트워킹 구성 수정

- 머신 풀 추가, 수정 또는 제거

- 사용자 워크로드 모니터링 활성화 또는 비활성화

- 업그레이드 시작

유지 관리 제외를 적용하려면 시스템 풀 자동 스케일링 또는 자동 업그레이드 정책이 비활성화되었는지 확인합니다. 유지 관리 제외가 해제된 후 필요에 따라 머신 풀 자동 스케일링 또는 자동 업그레이드 정책을 활성화합니다.

2.3.3.2. Red Hat 시작 변경 사항

Red Hat SRE(사이트 안정성 엔지니어링)는 GitOps 워크플로우 및 완전히 자동화된 CI/CD 파이프라인을 사용하여 OpenShift Dedicated의 인프라, 코드 및 구성을 관리합니다. 이러한 프로세스를 통해 Red Hat은 고객에게 부정적인 영향을 주지 않고 지속적으로 서비스 개선을 안전하게 도입할 수 있습니다.

제안된 모든 변경 사항은 체크인 시 즉시 일련의 자동화된 검증을 거칩니다. 그런 다음 자동화된 통합 테스트를 수행한 스테이징 환경에 변경 사항이 배포됩니다. 마지막으로 변경 사항이 프로덕션 환경에 배포됩니다. 각 단계는 완전히 자동화됩니다.

승인된 SRE 검토자는 각 단계에 대한 진행 사항을 승인해야 합니다. 검토자는 변경을 제안한 개인과 같을 수 없습니다. 모든 변경 사항 및 승인은 GitOps 워크플로우의 일부로 완전히 감사할 수 있습니다.

일부 변경 사항은 기능 플래그를 사용하여 지정된 클러스터 또는 고객에 대한 새 기능의 가용성을 제어하여 점진적으로 릴리스됩니다.

2.3.3.3. 패치 관리

일반 z-stream 업그레이드의 버그 및 취약점에 대해 OpenShift Container Platform 소프트웨어 및 기본 변경 불가능한 RHCOS(Red Hat Enterprise Linux CoreOS) 운영 체제 이미지가 패치됩니다. OpenShift Container Platform 설명서에서 RHCOS 아키텍처에 대해 자세히 알아보십시오.

2.3.3.4. 릴리스 관리

Red Hat은 클러스터를 자동으로 업그레이드하지 않습니다. OpenShift Cluster Manager 웹 콘솔을 사용하여 정기적으로 클러스터를 업그레이드(재개 업그레이드) 또는 한 번만(개인 업그레이드)하도록 예약할 수 있습니다. Red Hat은 클러스터가 심각한 영향을 미치는 CVE의 영향을 받는 경우에만 클러스터를 새로운 z-stream 버전으로 강제 업그레이드할 수 있습니다. OpenShift Cluster Manager 웹 콘솔에서 모든 클러스터 업그레이드 이벤트 기록을 검토할 수 있습니다. 릴리스에 대한 자세한 내용은 라이프 사이클 정책을 참조하십시오.

2.3.4. 보안 및 규정 준수

보안 및 규정 준수 준수에는 보안 제어 및 규정 준수 인증과 같은 작업이 포함됩니다.

2.3.4.1. 데이터 분류

Red Hat은 데이터 분류 표준을 정의하고 준수하여 데이터의 민감도를 결정하고 데이터를 수집, 사용, 전송 및 처리하는 동안 데이터의 기밀성과 무결성에 대한 고유 한 위험을 강조합니다. 고객 소유 데이터는 최고 수준의 민감도 및 처리 요구 사항으로 분류됩니다.

2.3.4.2. 데이터 관리

OpenShift Dedicated는 AWS KMS(Key Management Service) 및 Google Cloud KMS와 같은 클라우드 공급자 서비스를 사용하여 영구 데이터의 암호화 키를 안전하게 관리할 수 있습니다. 이러한 키는 모든 컨트롤 플레인, 인프라 및 작업자 노드 루트 볼륨을 암호화하는 데 사용됩니다. 고객은 설치 시 루트 볼륨을 암호화하기 위해 자체 KMS 키를 지정할 수 있습니다. PV(영구 볼륨)는 키 관리에 KMS도 사용합니다. 고객은 KMS 키 ARM(Amazon Resource Name) 또는 ID를 참조하는 새 StorageClass 를 생성하여 PV를 암호화하기 위해 자체 KMS 키를 지정할 수 있습니다.

고객이 OpenShift Dedicated 클러스터를 삭제하면 컨트롤 플레인 데이터 볼륨 및 고객 애플리케이션 데이터 볼륨(예: PV)을 포함하여 모든 클러스터 데이터가 영구적으로 삭제됩니다.

2.3.4.3. 취약점 관리

Red Hat은 업계 표준 툴을 사용하여 OpenShift Dedicated의 주기적인 취약점 스캔을 수행합니다. 확인된 취약점은 심각도에 따라 타임라인에 따라 수정으로 추적됩니다. 취약점 검사 및 수정 작업은 규정 준수 인증 감사 과정에서 타사 평가자가 확인하기 위해 문서화됩니다.

2.3.4.4. 네트워크 보안

2.3.4.4.1. 방화벽 및 DDoS 보호

각 OpenShift Dedicated 클러스터는 방화벽 규칙(AWS Security Groups 또는 Google Cloud Compute Engine 방화벽 규칙)을 사용하여 클라우드 인프라 수준에서 보안 네트워크 구성으로 보호됩니다. AWS의 OpenShift Dedicated 고객도 AWS Shield Standard 를 사용하여 DDoS 공격으로부터 보호됩니다. 마찬가지로 Google Cloud의 OpenShift Dedicated에서 사용하는 모든 Google Cloud 로드 밸런서 및 공용 IP 주소는 Google Cloud Armor Standard 를 사용하여 DDoS 공격으로부터 보호됩니다.

2.3.4.4.2. 구성 요소 및 트래픽 흐름 암호화

OpenShift Dedicated 구성 요소는 보안 통신을 위해 TLS(Transport Layer Security)를 사용하도록 구성되어 성능 및 보안 개선을 위해 TLS 1.3의 우선 순위를 지정합니다. TLS 1.3을 아직 지원하지 않는 구성 요소의 경우 강력한 TLS 1.2 암호화 제품군이 구성됩니다. 이 포괄적인 TLS 구성을 사용하면 OpenShift Dedicated 환경 내에서 다양한 트래픽 흐름을 암호화할 수 있습니다. 자세한 내용은 OpenShift 및 부록 4(Online Subscription Services)의 TLS 구성 을 참조하십시오.

- 버전 4.7부터 OpenShift API 서버(포트 6443), kube-controller(port 10257) 및 kube-scheduler(포트 10259)는 보안 암호화 제품군 세트로 TLS 1.3을 사용하도록 구성됩니다.

- 웹 콘솔과 etcd는 보안 기본 암호화 제품군도 사용합니다. OpenShift가 업데이트되므로 이러한 구성 요소에 대해 이전 버전과 더 취약한 암호화 옵션이 더 이상 사용되지 않습니다.

- Kubelet(포트 10248, 10250)은 TLS 1.3을 사용하여 노드 수준 작업을 보호하고 특정 TLS 1.2 암호화 제품군의 명시적 구성도 허용합니다.

- Ingress 트래픽은 강력한 TLS 구성을 통해 OpenShift Dedicated Router에 의해 보호됩니다. 기본적으로 강화된 TLS 1.2 암호화 제품군 세트를 사용하며 OpenShift 4.6 이상에서는 보안 강화를 위해 TLS 1.3도 지원합니다.

- 기본적으로 OpenShift 4는 다양한 내부 서비스에서 보안 TLS 구성을 활성화하여 통신을 보호합니다. 이러한 서비스에는 Machine Config Server(포트 22623-22624), 노드 내보내기(9100-9101 포트), Kube RBAC 프록시(포트 9192)가 포함됩니다.

2.3.4.4.3. 프라이빗 클러스터 및 네트워크 연결

고객은 선택적으로 인터넷에서 클러스터 컨트롤 플레인 또는 애플리케이션에 액세스할 수 없도록 OpenShift Dedicated 클러스터 끝점(웹 콘솔, API 및 애플리케이션 라우터)을 비공개로 구성할 수 있습니다.

AWS의 경우 고객은 AWS VPC 피어링, AWS VPN 또는 AWS Direct Connect를 통해 OpenShift Dedicated 클러스터에 대한 프라이빗 네트워크 연결을 구성할 수 있습니다.

2.3.4.4.4. 클러스터 네트워크 액세스 제어

세분화된 네트워크 액세스 제어 규칙은 프로젝트당 고객이 구성할 수 있습니다.

2.3.4.5. 침투 테스트

Red Hat은 OpenShift Dedicated에 대해 주기적인 침투 테스트를 수행합니다. 테스트는 업계 표준 툴 및 모범 사례를 사용하여 독립적인 내부 팀에서 수행합니다.

발견된 모든 문제는 심각도에 따라 우선순위가 지정됩니다. 오픈 소스 프로젝트에 속한 모든 문제는 커뮤니티와 공유하여 문제를 해결합니다.

2.3.4.6. 규정 준수

OpenShift Dedicated는 보안 및 제어를 위한 일반적인 업계 모범 사례를 따릅니다. 인증은 다음 표에 설명되어 있습니다.

| 규정 준수 | AWS의 OpenShift Dedicated | Google Cloud의 OpenShift Dedicated |

|---|---|---|

| HIPAA 정규화된 | 제공됨 (고객 클라우드 서브스크립션만) | 제공됨 (고객 클라우드 서브스크립션만) |

| ISO 27001 | 제공됨 | 제공됨 |

| ISO 27017 | 제공됨 | 제공됨 |

| ISO 27018 | 제공됨 | 제공됨 |

| PCI DSS 4.0 | 제공됨 | 제공됨 |

| SOC 1 유형 2 | 제공됨 | 제공됨 |

| SOC 2 유형 2 | 제공됨 | 제공됨 |

| SOC 3 | 제공됨 | 제공됨 |

2.3.5. 재해 복구

OpenShift Dedicated는 Pod, 작업자 노드, 인프라 노드, 컨트롤 플레인 노드 및 가용성 영역 수준에서 발생하는 오류에 대한 재해 복구를 제공합니다.

모든 재해 복구를 위해서는 고객이 고가용성 애플리케이션, 스토리지 및 클러스터 아키텍처 배포(예: 단일 영역 배포 대 다중 영역 배포)를 배포하기 위한 모범 사례를 사용해야 합니다.

하나의 단일 영역 클러스터는 가용성 영역 또는 지역 중단 시 재해 방지 또는 복구를 제공하지 않습니다. 고객이 유지 관리하는 장애 조치가 있는 여러 단일 영역 클러스터는 영역 또는 지역 수준에서 중단을 설명할 수 있습니다.

하나의 다중 영역 클러스터는 전체 지역 중단 시 재해 방지 또는 복구를 제공하지 않습니다. 고객이 유지 관리하는 장애 조치가 있는 여러 다중 영역 클러스터는 지역 수준에서 중단을 설명할 수 있습니다.

2.4. SRE 및 서비스 계정 액세스

2.4.1. ID 및 액세스 관리

Red Hat 사이트 안정성 엔지니어링(SRE) 팀에서 대부분의 액세스는 자동화된 구성 관리를 통해 클러스터 Operator를 사용하여 수행됩니다.

Workload Identify Federation (WIF) 인증 유형으로 생성된 Google Cloud 클러스터의 OpenShift Dedicated에서는 SRE 액세스에 Operator를 사용하지 않습니다. 대신 SRE 계정 액세스에 필요한 필수 역할은 WIF 구성 생성의 일부로 sd-sre-platform-gcp-access 그룹에 할당되며 OpenShift Cluster Manager에서 클러스터를 배포하기 전에 유효성을 검사합니다. WIF 구성에 대한 자세한 내용은 추가 리소스를 참조하십시오.

2.4.1.1. 하위 프로세서

사용 가능한 하위 프로세서 목록은 Red Hat 고객 포털의 Red Hat 하위 프로세서 목록을 참조하십시오.

2.4.1.2. 모든 OpenShift Dedicated 클러스터에 대한 SRE 액세스

SRES는 프록시를 통해 OpenShift Dedicated 클러스터에 액세스합니다. 프록시는 로그인할 때 SREs에 대한 OpenShift Dedicated 클러스터에서 서비스 계정을 mints합니다. OpenShift Dedicated 클러스터에 대해 구성된 ID 공급자가 없으므로 SREs는 로컬 웹 콘솔 컨테이너를 실행하여 프록시에 액세스합니다. SRES는 클러스터 웹 콘솔에 직접 액세스하지 않습니다. SRES는 감사 가능성을 보장하기 위해 개별 사용자로 인증해야 합니다. 모든 인증 시도는 SIEM(Security Information and Event Management) 시스템에 기록됩니다.

2.4.1.3. OpenShift Dedicated에서 권한 있는 액세스 제어

Red Hat SRE는 OpenShift Dedicated 및 퍼블릭 클라우드 공급자 구성 요소에 액세스할 때 최소 권한 원칙을 따릅니다. 수동 SRE 액세스에는 다음 네 가지 기본 카테고리가 있습니다.

- SRE 관리자 액세스는 일반적인 2단계 인증 및 권한 상승 없이 Red Hat 고객 포털을 통해 액세스할 수 있습니다.

- SRE 관리자 액세스는 일반적인 2 단계 인증 및 권한 상승 없이 Red Hat 회사 SSO를 통해 액세스할 수 있습니다.

- OpenShift 고도(Red Hat SSO를 사용한 수동 상승)입니다. 이는 완전히 감사되고 관리 승인이 모든 작업 SREs에 필요합니다.

- 클라우드 공급자 콘솔 또는 CLI 액세스를 위한 수동 확장인 클라우드 공급자 액세스 또는 고도. 액세스는 60분으로 제한되며 완전히 감사됩니다.

이러한 액세스 유형 각각은 구성 요소에 대한 서로 다른 수준의 액세스 권한을 갖습니다.

| Component | 일반적인 SRE 관리자 액세스(Red Hat 고객 포털) | 일반적인 SRE 관리자 액세스(Red Hat SSO) | OpenShift elevation | 클라우드 공급자 액세스 |

|---|---|---|---|---|

| OpenShift Cluster Manager | R/W | 액세스 권한 없음 | 액세스 권한 없음 | 액세스 권한 없음 |

| OpenShift 웹 콘솔 | 액세스 권한 없음 | R/W | R/W | 액세스 권한 없음 |

| 노드 운영 체제 | 액세스 권한 없음 | 승격된 OS 및 네트워크 권한의 특정 목록입니다. | 승격된 OS 및 네트워크 권한의 특정 목록입니다. | 액세스 권한 없음 |

| AWS 콘솔 | 액세스 권한 없음 | 액세스 권한은 없지만 클라우드 공급자 액세스를 요청하는 데 사용되는 계정입니다. | 액세스 권한 없음 | SRE ID를 사용하는 모든 클라우드 공급자 권한. |

2.4.1.4. 클라우드 인프라 계정에 대한 SRE 액세스

Red Hat 직원은 일상적인 OpenShift Dedicated 작업 과정에서 클라우드 인프라 계정에 액세스하지 않습니다. 긴급 문제 해결을 위해 Red Hat SRE는 클라우드 인프라 계정에 액세스하기 위한 잘 정의되고 감사 가능한 절차가 있습니다.

AWS에서 SREs는 AWS STS(보안 토큰 서비스)를 사용하여 BYOCAdminAccess 사용자에 대한 단기 AWS 액세스 토큰을 생성합니다. STS 토큰에 대한 액세스는 감사 기록 및 개별 사용자로 추적할 수 있습니다. BYOCAdminAccess 에는 AdministratorAccess IAM 정책이 연결되어 있습니다.

Google Cloud에서 SREs 액세스 리소스는 Red Hat SAML ID 공급자(IDP)에 대해 인증됩니다. IDP는 라이브 만료 기간이 있는 토큰을 인증합니다. 토큰 발행은 기업 Red Hat IT에서 감사할 수 있으며 개별 사용자와 다시 연결됩니다.

2.4.1.5. Red Hat 지원 액세스

Red Hat CEE 팀의 구성원은 일반적으로 클러스터의 일부에 대한 읽기 전용 액세스 권한을 갖습니다. 특히 CEE는 핵심 및 제품 네임스페이스에 대한 액세스를 제한하고 고객 네임스페이스에 대한 액세스 권한이 없습니다.

| Role | 코어 네임스페이스 | 계층화된 제품 네임스페이스 | 고객 네임스페이스 | 클라우드 인프라 계정* |

|---|---|---|---|---|

| OpenShift SRE | 읽기: 모두 쓰기: Very 제한된 [1] | 읽기: 모두 쓰기: 없음 | 읽기: None[2] 쓰기: 없음 | 읽기: 모두 [3] 모두 쓰기 [3] |

| CEE | 읽기: 모두 쓰기: 없음 | 읽기: 모두 쓰기: 없음 | 읽기: None[2] 쓰기: 없음 | 읽기: 없음 쓰기: 없음 |

| 고객 관리자 | 읽기: 없음 쓰기: 없음 | 읽기: 없음 쓰기: 없음 | 읽기: 모두 쓰기: 모두 | 읽기: Limited[4] 쓰기: 제한됨[4] |

| 고객 사용자 | 읽기: 없음 쓰기: 없음 | 읽기: 없음 쓰기: 없음 | 읽기: 제한됨[5] 쓰기: 제한됨[5] | 읽기: 없음 쓰기: 없음 |

| 다른 모든 사람 | 읽기: 없음 쓰기: 없음 | 읽기: 없음 쓰기: 없음 | 읽기: 없음 쓰기: 없음 | 읽기: 없음 쓰기: 없음 |

Cloud Infrastructure Account는 기본 AWS 또는 Google Cloud 계정을 나타냅니다.

- 실패한 배포, 클러스터 업그레이드, 잘못된 작업자 노드 교체와 같은 일반적인 사용 사례 처리로 제한됩니다.

- Red Hat 직원은 기본적으로 고객 데이터에 액세스할 수 없습니다.

- 클라우드 인프라 계정에 대한 SRE 액세스는 문서화된 문제 발생 시 예외적인 문제 해결을 위한 "중요" 절차입니다.

- 고객 관리자는 Cloud Infrastructure Access를 통해 클라우드 인프라 계정 콘솔에 대한 액세스가 제한되어 있습니다.

- 고객 관리자가 RBAC를 통해 부여한 항목 및 사용자가 생성한 네임스페이스로 제한됩니다.

2.4.1.6. 고객 액세스

고객 액세스는 고객이 생성한 네임스페이스 및 고객 관리자 역할에서 RBAC를 사용하여 부여하는 권한으로 제한됩니다. 기본 인프라 또는 제품 네임스페이스에 대한 액세스는 일반적으로 cluster-admin 액세스없이 허용되지 않습니다. 고객 액세스 및 인증에 대한 자세한 내용은 설명서의 인증 이해 섹션에서 확인할 수 있습니다.

2.4.1.7. 액세스 승인 및 검토

새로운 SRE 사용자 액세스에는 관리 승인이 필요합니다. 분리되거나 전송된 SRE 계정은 자동화된 프로세스를 통해 권한 있는 사용자로 제거됩니다. 또한 SRE는 권한 있는 사용자 목록의 관리 서명을 포함하여 정기적인 액세스 검토를 수행합니다.

2.4.2. SRE 클러스터 액세스

OpenShift Dedicated 클러스터에 대한 Red Hat SRE 액세스는 여러 필수 인증 계층을 통해 제어되며 모두 엄격한 회사 정책에 의해 관리됩니다. 모든 인증 시도는 클러스터에 액세스하려고 하며 클러스터 내의 변경 사항은 해당 작업을 담당하는 SRE의 특정 계정 ID와 함께 감사 로그 내에 기록됩니다. 이러한 감사 로그는 고객의 클러스터에 대한 모든 변경 사항이 Red Hat의 관리 서비스 지침을 구성하는 엄격한 정책과 절차를 준수하는지 확인하는 데 도움이 됩니다.

아래에 제시된 정보는 SRE가 고객의 클러스터에 액세스하기 위해 수행해야 하는 프로세스에 대한 개요입니다.

- Red Hat SRE는 Red Hat SSO(Cloud Services)에서 새로 고침 ID 토큰을 요청합니다. 이 요청이 인증됩니다. 토큰은 15분 동안 유효합니다. 토큰이 만료되면 토큰을 다시 새로고침하여 새 토큰을 수신할 수 있습니다. 새 토큰으로 새로 고침하는 기능은 무제한입니다. 그러나 새 토큰으로 새로 고침하는 기능은 비활성화 후 30일 후에 취소됩니다.

- Red Hat SRE가 Red Hat VPN에 연결됩니다. VPN에 대한 인증은 Red Hat Corporate Identity and Access Management 시스템(RH IAM)에 의해 완료됩니다. RH IAM을 사용하면 SRE는 다중 요소이며 그룹 및 기존 온보딩 및 오프보딩 프로세스를 통해 조직당 내부적으로 관리할 수 있습니다. SRE가 인증 및 연결되면 SRE가 클라우드 서비스 플릿 관리 플레인에 액세스할 수 있습니다. 클라우드 서비스 플릿 관리 플레인을 변경하려면 많은 승인 계층이 필요하며 엄격한 회사 정책에 의해 유지 관리됩니다.

- 권한 부여가 완료되면 플릿 관리 플레인에 SRE 로그가 기록되고 플릿 관리 플레인에서 생성한 서비스 계정 토큰이 수신됩니다. 토큰은 15분 동안 유효합니다. 토큰이 더 이상 유효하지 않으면 삭제됩니다.

플릿 관리 플레인에 대한 액세스 권한이 부여된 SRE는 네트워크 구성에 따라 다양한 방법을 사용하여 클러스터에 액세스합니다.

- 프라이빗 또는 공용 클러스터에 액세스: 포트 6443에서 암호화된 HTTP 연결을 사용하여 요청이 특정 NLB(Network Load Balancer)를 통해 전송됩니다.

- PrivateLink 클러스터에 액세스: 요청이 Red Hat Transit Gateway로 전송되어 리전당 Red Hat VPC에 연결됩니다. 요청을 수신하는 VPC는 대상 프라이빗 클러스터 리전에 따라 달라집니다. VPC에는 고객의 PrivateLink 클러스터에 대한 PrivateLink 엔드포인트가 포함된 프라이빗 서브넷이 있습니다.

- PSC(Private Service Connect) 클러스터에 액세스: 요청은 안전하고 신뢰할 수 있는 네트워크를 통해 트래픽을 Google Cloud의 관리 프로젝트로 라우팅하는 Red Hat의 내부 백엔드 인프라로 전송됩니다. Red Hat 관리 프로젝트에는 여러 리전의 서브넷으로 구성된 VPC가 포함되어 있으며 각각 해당 리전의 고객 클러스터에 대한 개인 액세스를 제공하는 PSC 엔드포인트가 포함되어 있습니다. 트래픽은 적절한 지역 서브넷을 통해 라우팅되므로 공용 인터넷을 통과하지 않고도 클러스터에 대한 보안 및 개인 액세스를 보장합니다.

2.4.3. 서비스 계정에서 SRE 보유 프로젝트에서 AWS IAM 역할을 가정하는 방법

AWS STS(보안 토큰 서비스)를 사용하는 OpenShift Dedicated를 설치하면 클러스터별 Operator AWS IAM(Identity and Access Management) 역할이 생성됩니다. 이러한 IAM 역할을 사용하면 ROSA 클러스터 Operator가 핵심 OpenShift 기능을 실행할 수 있습니다.

클러스터 Operator는 서비스 계정을 사용하여 IAM 역할을 가정합니다. 서비스 계정에서 IAM 역할을 가정하면 서비스 계정에서 클러스터 Operator의 Pod에서 사용할 임시 AWS STS 인증 정보가 제공됩니다. assumed 역할에 필요한 AWS 권한이 있는 경우 서비스 계정에서 Pod에서 AWS SDK 작업을 실행할 수 있습니다.

2.4.3.1. Red Hat SRE 보유 프로젝트에서 AWS IAM 역할을 가정하기 위한 워크플로우

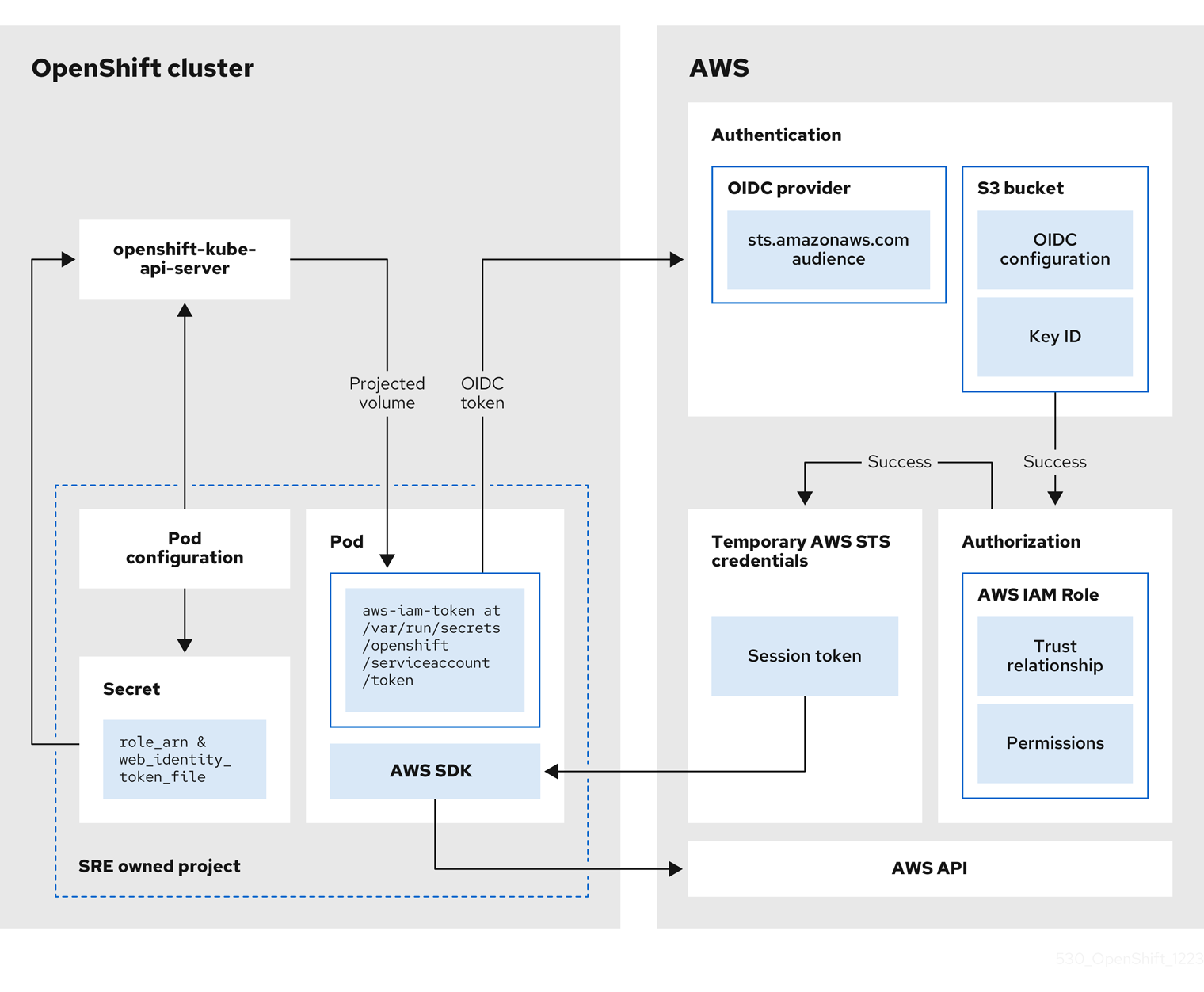

다음 다이어그램은 SRE 보유 프로젝트에서 AWS IAM 역할을 가정하는 워크플로우를 보여줍니다.

그림 2.1. SRE 보유 프로젝트에서 AWS IAM 역할을 가정하기 위한 워크플로우

워크플로우에는 다음 단계가 있습니다.

클러스터 Operator가 실행하는 각 프로젝트 내에서 Operator의 배포 사양에는 예상 서비스 계정 토큰에 대한 볼륨 마운트와 Pod에 대한 AWS 인증 정보 구성이 포함된 시크릿이 있습니다. 토큰은 오디언스 바인딩 및 시간 바인딩입니다. ROSA는 매시간 새 토큰을 생성하고 AWS SDK는 AWS 인증 정보 구성이 포함된 마운트된 시크릿을 읽습니다. 이 구성에는 마운트된 토큰 및 AWS IAM 역할 ARN의 경로가 있습니다. 시크릿의 인증 정보 구성에는 다음이 포함됩니다.

-

AWS SDK 작업을 실행하는 데 필요한 권한이 있는 IAM 역할에 대한 ARN이 있는

$AWS_ARN_ROLE변수. -

서비스 계정의 OpenID Connect(OIDC) 토큰으로 Pod의 전체 경로가 있는

$AWS_LOAD_IDENTITY_TOKEN_FILE변수. 전체 경로는/var/run/secrets/openshift/serviceaccount/token입니다.

-

AWS SDK 작업을 실행하는 데 필요한 권한이 있는 IAM 역할에 대한 ARN이 있는

-

클러스터 Operator에서 AWS IAM 역할로 간주하여 AWS IAM 역할(예: EC2)을 가정해야 하는 경우 Operator에서 실행되는 AWS SDK 클라이언트 코드는

AssumeRoleWithWebIdentityAPI 호출을 호출합니다. OIDC 토큰은 Pod에서 OIDC 공급자로 전달됩니다. 다음 요구 사항이 충족되면 공급자는 서비스 계정 ID를 인증합니다.

- ID 서명은 유효하며 개인 키로 서명됩니다.

sts.amazonaws.com대상은 OIDC 토큰에 나열되며 OIDC 공급자에 구성된 대상과 일치합니다.참고STS 클러스터를 사용하는 ROSA에서는 설치 중에 OIDC 공급자가 생성되고 기본적으로 서비스 계정 발행자로 설정됩니다.

sts.amazonaws.com대상은 OIDC 공급자에 기본적으로 설정됩니다.- OIDC 토큰이 만료되지 않았습니다.

- 토큰의 발행자 값에는 OIDC 공급자의 URL이 있습니다.

- 프로젝트 및 서비스 계정이 가정 중인 IAM 역할에 대한 신뢰 정책 범위에 있는 경우 권한 부여가 성공합니다.

- 인증 및 권한 부여에 성공하면 AWS 액세스 토큰, 시크릿 키 및 세션 토큰 형식의 임시 AWS STS 인증 정보가 서비스 계정에서 사용할 수 있도록 Pod에 전달됩니다. 인증 정보를 사용하면 서비스 계정에 IAM 역할에 활성화된 AWS 권한이 일시적으로 부여됩니다.

- 클러스터 Operator가 실행되면 Pod에서 AWS SDK를 사용하는 Operator는 예상 서비스 계정에 대한 경로가 있는 시크릿과 AWS IAM 역할 ARN을 사용하여 OIDC 공급자에 대해 인증합니다. OIDC 공급자는 AWS API에 대한 인증에 대한 임시 STS 자격 증명을 반환합니다.

2.4.4. 추가 리소스

WIF 구성 및 SRE 액세스 역할에 대한 자세한 내용은 WIF 구성 생성을 참조하십시오.

2.5. OpenShift Dedicated의 가용성 이해

가용성 및 재해 방지는 모든 애플리케이션 플랫폼에서 매우 중요한 요소입니다. OpenShift Dedicated는 여러 수준에서 장애에 대한 많은 보호 기능을 제공하지만 고객이 배포한 애플리케이션은 고가용성을 위해 적절하게 구성해야 합니다. 또한 발생할 수 있는 클라우드 공급자 중단을 고려하여 여러 가용성 영역에 클러스터를 배포하거나 장애 조치 메커니즘을 사용하여 여러 클러스터를 유지 관리하는 등 다른 옵션을 사용할 수 있습니다.

2.5.1. 잠재적인 실패 지점

OpenShift Container Platform에서는 다운타임으로부터 워크로드를 보호할 수 있는 다양한 기능과 옵션을 제공하지만 이러한 기능을 활용하기 위해서는 애플리케이션을 적절하게 조정해야 합니다.

OpenShift Dedicated는 Red Hat site Reliability Engineer(SRE) 지원 및 다중 영역 클러스터를 배포하는 옵션을 추가하여 여러 가지 일반적인 Kubernetes 문제를 추가로 보호할 수 있지만 컨테이너 또는 인프라가 여전히 실패할 수 있는 여러 가지 방법이 있습니다. 잠재적인 장애 지점을 이해하면 위험을 이해하고 애플리케이션과 클러스터를 각각의 특정 수준에서 필요에 따라 탄력적으로 조정할 수 있습니다.

중단은 여러 수준의 인프라 및 클러스터 구성 요소에서 발생할 수 있습니다.

2.5.1.1. 컨테이너 또는 Pod 실패

Pod는 설계상 짧은 기간 동안 존재해야 합니다. 애플리케이션 Pod의 여러 인스턴스가 실행되는 개별 Pod 또는 컨테이너의 문제로부터 보호되도록 서비스를 적절하게 스케일링합니다. 노드 스케줄러는 복원력을 추가로 개선하기 위해 이러한 워크로드가 서로 다른 작업자 노드에 분산되어 있는지도 확인할 수 있습니다.

가능한 Pod 오류를 처리할 때 스토리지가 애플리케이션에 연결된 방식을 이해하는 것도 중요합니다. 단일 포드에 연결된 단일 영구 볼륨은 포드 확장의 모든 이점을 활용할 수 없지만 복제된 데이터베이스, 데이터베이스 서비스 또는 공유 스토리지는 가능합니다.

계획된 유지 관리 기간(예: 업그레이드) 동안 애플리케이션의 중단을 방지하려면 Pod 중단 예산을 정의하는 것이 중요합니다. 이는 Kubernetes API의 일부이며 다른 오브젝트 유형과 마찬가지로 OpenShift CLI(oc)를 사용하여 관리할 수 있습니다. 유지 관리를 위해 노드를 드레이닝하는 것과 같이 작업 중에 pod 에 대한 보안 제약 조건을 지정할 수 있습니다.

2.5.1.2. 작업자 노드 장애

작업자 노드는 애플리케이션 pod가 포함된 가상 머신입니다. 기본적으로 OpenShift Dedicated 클러스터에는 단일 가용성 영역 클러스터에 대해 최소 4개의 작업자 노드가 있습니다. 작업자 노드 오류가 발생하는 경우 기존 노드와 관련된 문제가 해결되거나 노드가 교체될 때까지 충분한 용량이 있는 한 작업자 노드가 작동되도록 Pod가 재배치됩니다. 더 많은 작업자 노드는 단일 노드 중단을 방지할 수 있으며 노드 장애가 발생할 경우 Pod를 다시 예약할 수 있는 적절한 클러스터 용량을 보장합니다.

가능한 노드 오류를 처리할 때 스토리지의 영향을 이해하는 것도 중요합니다.

2.5.1.3. 클러스터 장애

OpenShift Dedicated 클러스터에는 3개 이상의 컨트롤 플레인 노드와 3개의 인프라 노드가 있으며, 이 노드는 단일 영역 또는 선택한 클러스터 유형에 따라 여러 영역에서 사전 구성되어 있습니다. 즉, 컨트롤 플레인 및 인프라 노드는 작업자 노드와 동일한 복원력을 가지며 Red Hat에서 완전히 관리할 수 있는 추가 이점이 있습니다.

완전한 컨트롤 플레인 노드 중단이 발생하면 OpenShift API가 작동하지 않으며 기존 작업자 노드 pod는 영향을 받지 않습니다. 그러나 Pod 또는 노드 중단이 동시에 발생하는 경우 새 Pod 또는 노드를 추가하거나 예약하기 전에 컨트롤 플레인 노드를 복구해야 합니다.

인프라 노드에서 실행되는 모든 서비스는 Red Hat에서 고가용성으로 구성하고 인프라 노드에 분산합니다. 완전한 인프라 중단이 발생하는 경우 이러한 노드가 복구될 때까지 이러한 서비스를 사용할 수 없습니다.

2.5.1.4. 영역 장애

퍼블릭 클라우드 공급자의 영역 오류는 작업자 노드, 블록 또는 공유 스토리지, 단일 가용성 영역과 관련된 로드 밸런서와 같은 모든 가상 구성 요소에 영향을 미칩니다. 영역 장애로부터 보호하기 위해 OpenShift Dedicated는 다중 가용 영역 클러스터라는 세 가지 가용성 영역에 분산된 클러스터에 대한 옵션을 제공합니다. 기존 상태 비저장 워크로드는 충분한 용량이 있는 경우 중단 시 영향을 받지 않는 영역에 재배포됩니다.

2.5.1.5. 스토리지 장애

상태 저장 애플리케이션을 배포한 경우 스토리지는 중요한 구성 요소이며 고가용성을 고려할 때 고려해야 합니다. 단일 블록 스토리지 PV는 Pod 수준에서도 중단을 방지할 수 없습니다. 스토리지의 가용성을 유지하는 가장 좋은 방법은 복제된 스토리지 솔루션, 중단의 영향을 받지 않는 공유 스토리지 또는 클러스터와 무관한 데이터베이스 서비스를 사용하는 것입니다.

2.6. OpenShift Dedicated 업데이트 라이프 사이클

2.6.1. 개요

Red Hat은 고객 및 파트너사가 플랫폼에서 실행되는 애플리케이션을 효과적으로 계획, 배포 및 지원할 수 있도록 OpenShift Dedicated의 제품 라이프 사이클을 제공합니다. Red Hat은 투명성을 구현하기 위해 라이프 사이클을 공개하고 문제가 발생할 경우 이러한 정책에 예외가 있을 수 있습니다.

OpenShift Dedicated는 Red Hat OpenShift의 관리형 배포이며 독립적인 릴리스 일정을 유지 관리합니다. 관리형 오퍼링에 대한 자세한 내용은 OpenShift Dedicated 서비스 정의에서 확인할 수 있습니다. 특정 버전에 대한 보안 권고 및 버그 수정 권고의 가용성은 Red Hat OpenShift Container Platform 라이프 사이클 정책에 따라 다르며 OpenShift Dedicated 유지 관리 일정에 따라 다릅니다.

2.6.2. 정의

| 버전 형식 | 메이저 | 마이너 | 패치 | Major.minor.patch |

|---|---|---|---|---|

| x | y | z | x.y.z | |

| 예제 | 4 | 5 | 21 | 4.5.21 |

- 주요 릴리스 또는 X 릴리스

주요 릴리스 또는 X-release(X.y.z)로만 참조됩니다.

예

- "major 릴리스 5" → 5.y.z

- "major 릴리스 4" → 4.y.z

- "major 릴리스 3" → 3.y.z

- 마이너 릴리스 또는 Y 릴리스

마이너 릴리스 또는 Y-release(x.Y.z)로만 참조됩니다.

예

- "최소 릴리스 4" → 4.4.z

- "minor 릴리스 5" → 4.5.z

- "minor 릴리스 6" → 4.6.z

- 패치 릴리스 또는 Z 릴리스

패치 릴리스 또는 Z-release (x.y.Z)라고 합니다.

예

- "마이너 릴리스 5의 패치 릴리스 14" → 4.5.14

- "마이너 릴리스 5의 패치 릴리스 25" → 4.5.25

- "마이너 릴리스 6의 패치 릴리스 26" → 4.6.26

2.6.3. 주요 버전 (X.y.z)

OpenShift Dedicated의 주요 버전(예: 버전 4)은 후속 주요 버전 릴리스 또는 제품 종료 후 1년 동안 지원됩니다.

예제

- 1월 1일 OpenShift Dedicated에서 버전 5를 사용할 수 있는 경우 12개월 동안 관리 클러스터에서 12개월까지 계속 실행할 수 있습니다. 이 기간 후에 클러스터를 업그레이드하거나 버전 5로 마이그레이션해야 합니다.

2.6.4. 마이너 버전 (x.Y.z)

Red Hat은 4.8 OpenShift Container Platform 마이너 버전부터는 지정된 마이너 버전의 정식 출시 후 최소 16개월 동안 모든 마이너 버전을 지원합니다. 패치 버전은 지원 기간의 영향을 받지 않습니다.

고객은 지원 기간이 종료 60일, 30일, 15일 전에 알림을 받습니다. 클러스터는 지원 기간이 종료되기 전에 지원되는 가장 오래된 마이너 버전의 최신 패치 버전으로 업그레이드해야 합니다. 그렇지 않으면 클러스터가 "제한된 지원" 상태가 됩니다.

예제

- 고객의 클러스터는 현재 4.13.8에서 실행되고 있습니다. 4.13 마이너 버전은 2023년 5월 17일에 일반적으로 사용 가능하게 되었습니다.

- 7월 19일, 8월 16일, 2024년 9월 2일, 고객은 클러스터가 지원되는 마이너 버전으로 업그레이드되지 않은 경우 2024년 9월 17일 "제한된 지원" 상태를 입력한다는 통지를 받습니다.

- 클러스터는 2024년 9월 17일까지 4.14 이상으로 업그레이드해야 합니다.

- 업그레이드가 수행되지 않은 경우 클러스터는 "제한된 지원" 상태로 표시됩니다.

2.6.5. 패치 버전 (x.y.Z)

마이너 버전이 지원되는 기간 동안 별도로 지정하지 않는 한 Red Hat은 모든 OpenShift Container Platform 패치 버전을 지원합니다.

플랫폼 보안 및 안정성의 이유로 패치 릴리스가 더 이상 사용되지 않을 수 있으므로 해당 릴리스의 설치를 방지하고 필수 업그레이드를 트리거할 수 있습니다.

예제

- 4.7.6에는 중요한 CVE가 포함되어 있습니다.

- CVE의 영향을 받는 모든 릴리스는 지원되는 패치 릴리스 목록에서 제거됩니다. 또한 4.7.6을 실행하는 모든 클러스터는 48시간 이내에 자동 업그레이드를 위해 예약됩니다.

2.6.6. 제한된 지원 상태

클러스터가 제한된 지원 상태로 전환되면 Red Hat은 더 이상 클러스터를 사전 모니터링하지 않으며 SLA는 더 이상 적용되지 않으며 SLA에 대해 요청된 크레딧이 거부됩니다. 이는 더 이상 제품 지원이 없다는 의미는 아닙니다. 일부 경우 위반 요인을 수정하면 클러스터가 완전히 지원되는 상태로 돌아갈 수 있습니다. 그러나 다른 경우에는 클러스터를 삭제하고 다시 생성해야 할 수도 있습니다.

다음 시나리오를 포함하여 여러 가지 이유로 클러스터가 제한된 지원 상태로 전환될 수 있습니다.

- 라이프 사이클 종료일 전에 클러스터를 지원되는 버전으로 업그레이드하지 않는 경우

Red Hat은 라이프 사이클 종료일 이후 버전에 대해 런타임 또는 SLA를 보장하지 않습니다. 지속적인 지원을 받으려면 만료일 이전에 클러스터를 지원되는 버전으로 업그레이드합니다. 지원 기간이 만료되기 전에 클러스터를 업그레이드하지 않으면 클러스터가 지원되는 버전으로 업그레이드할 때까지 제한된 지원 상태로 전환됩니다.

Red Hat은 지원되지 않는 버전에서 지원되는 버전으로 업그레이드하기 위해 상업적으로 합리적인 지원을 제공합니다. 그러나 지원되는 업그레이드 경로를 더 이상 사용할 수 없는 경우 새 클러스터를 생성하고 워크로드를 마이그레이션해야 할 수 있습니다.

- 기본 OpenShift Dedicated 구성 요소 또는 Red Hat에서 설치 및 관리하는 기타 구성 요소를 제거하거나 교체하는 경우

- 클러스터 관리자 권한이 사용된 경우 Red Hat은 인프라 서비스, 서비스 가용성 또는 데이터 손실에 영향을 미치는 사용자를 포함하여 인증된 사용자의 작업에 대해 책임을 지지 않습니다. Red Hat이 이러한 작업을 감지하면 클러스터가 제한된 지원 상태로 전환될 수 있습니다. Red Hat은 상태 변경 사항을 사용자에게 알려주며 클러스터를 삭제하고 다시 생성해야 하는 수정 단계를 살펴보기 위해 작업을 되돌리거나 지원 케이스를 생성해야 합니다.

클러스터가 제한된 지원 상태로 전환되거나 추가 지원이 필요한 특정 작업에 대한 질문이 있는 경우 지원 티켓을 엽니다.

2.6.7. 지원되는 버전 예외 정책

Red Hat은 새로운 버전 또는 기존 버전을 추가하거나 제거할 수 있는 권한을 보유하거나 향후 마이너 릴리스 버전을 지연할 수 있으며, 이는 사전 통지 없이 버그 또는 보안 문제에 영향을 미치는 하나 이상의 중요한 프로덕션에서 확인되었습니다.

2.6.8. 설치 정책

Red Hat은 최신 지원 릴리스를 설치하는 것을 권장하지만 OpenShift Dedicated에서는 이전 정책에서 적용되는 모든 지원 릴리스의 설치를 지원합니다.

2.6.9. 필수 업그레이드

심각하거나 중요한 CVE 또는 Red Hat에서 식별한 다른 버그가 클러스터의 보안 또는 안정성에 크게 영향을 미치는 경우 고객은 영업일 기준 2일 이내에 다음 지원 패치 릴리스로 업그레이드해야 합니다.

극단적인 상황에서 Red Hat은 환경에 대한 CVE의 심각성에 대한 평가에 따라 2 일 이내에 클러스터를 예약하거나 수동으로 업데이트하도록 고객에게 알립니다. 2 일 후 업데이트가 실행되지 않는 경우 Red Hat은 잠재적인 보안 위반 또는 불안정성을 완화하기 위해 클러스터를 최신 보안 패치 릴리스로 자동 업데이트합니다. Red Hat은 자체 재량에 따라 지원 케이스 를 통해 고객이 요청한 경우 자동 업데이트를 일시적으로 지연할 수 있습니다.

2.6.10. 라이프 사이클 날짜

| 버전 | 정식 출시일 (GA) | 유지 관리 지원 종료 | EUS (Extended Update Support) 애드온 - 기간 1 종료 |

|---|---|---|---|

| 4.20 | 2025년 10월 21일 | 2027년 4월 21일 | 2027년 10월 21일 |

| 4.19 | 2025년 6월 17일 | 2026년 12월 17일 | |

| 4.18 | 2025년 2월 25일 | 2026년 8월 25일 | 2027년 2월 25일 |

| 4.17 | 2024년 10월 1일 | 2026년 4월 1일 | |

| 4.16 | 2024년 6월 27일 | 2025년 12월 27일 | 2026년 6월 27일 |

| 4.15 | 2024년 2월 27일 | 2025년 8월 27일 |

EUS (Extended Update Support) 애드온 - 기간 1은 4.16부터 짝수 버전을 사용하는 OpenShift Dedicated 고객에게 사용할 수 있으며 OpenShift Dedicated 서브스크립션에 추가 비용없이 포함되어 있습니다.

EUS (Extended Update Support) 애드온 - 기간 1은 적격 마이너 릴리스에 대한 지원 라이프 사이클을 18 개월에서 총 24 개월로 연장하는 주요 이점을 제공합니다. 이 6 개월 연장을 통해 조직은 미션 크리티컬 애플리케이션에 대한 안정성을 유지하고, 복잡한 규제 검증 일정을 충족하며, 전체 버전 업그레이드없이 중요하고 중요한 보안 업데이트 및 긴급 우선 순위의 버그 수정에 지속적으로 액세스하여 제한된 유지 관리 창을 관리할 수 있습니다.

확장 업데이트 지원 애드온 - Term 1을 OpenShift Dedicated 클러스터에 적용하려면 채널 그룹을 eus 로 업데이트해야 합니다. 확장 업데이트 지원 애드온에 대한 자세한 내용은 확장 업데이트 지원 애드온 을 참조하십시오.

2.6.11. OpenShift Dedicated GovCloud의 라이프 사이클 날짜

OpenShift Dedicated GovCloud는 암호화 모듈 유효성 검사 프로그램(CMVP)에서 테스트 중인 활성 상태 또는 구현 상태를 수신한 암호화 모듈을 사용해야 하는 FedRAMP 높은 보안 제어의 적용을 받습니다. 결과적으로 OpenShift 구현에서 RHEL CoreOS에 적용되는 모듈인 OpenSSL은 ROSA GovCloud가 제공하는 OpenShift 버전에 대한 결정 요인으로, 표준 OpenShift 지원 라이프사이클에서 드리프트를 생성할 수 있습니다.

| 버전 | 정식 출시일 (GA) | 종료일 |

|---|---|---|

| 4.15 | 2025년 5월 9일 | 2025년 12월 1일 |

| 4.16 | 2025년 10월 20일 | 2025년 12월 27일 |

Legal Notice

Copyright © Red Hat

OpenShift documentation is licensed under the Apache License 2.0 (https://www.apache.org/licenses/LICENSE-2.0).

Modified versions must remove all Red Hat trademarks.

Portions adapted from https://github.com/kubernetes-incubator/service-catalog/ with modifications by Red Hat.

Red Hat, Red Hat Enterprise Linux, the Red Hat logo, the Shadowman logo, JBoss, OpenShift, Fedora, the Infinity logo, and RHCE are trademarks of Red Hat, Inc., registered in the United States and other countries.

Linux® is the registered trademark of Linus Torvalds in the United States and other countries.

Java® is a registered trademark of Oracle and/or its affiliates.

XFS® is a trademark of Silicon Graphics International Corp. or its subsidiaries in the United States and/or other countries.

MySQL® is a registered trademark of MySQL AB in the United States, the European Union and other countries.

Node.js® is an official trademark of the OpenJS Foundation.

The OpenStack® Word Mark and OpenStack logo are either registered trademarks/service marks or trademarks/service marks of the OpenStack Foundation, in the United States and other countries and are used with the OpenStack Foundation’s permission. We are not affiliated with, endorsed or sponsored by the OpenStack Foundation, or the OpenStack community.

All other trademarks are the property of their respective owners.