블록 장치 가이드

Red Hat Ceph Storage 블록 장치 관리, 생성, 구성 및 사용

초록

1장. Ceph 블록 장치 소개

블록은 일련의 바이트 길이입니다(예: 데이터의 512바이트 블록). 많은 블록을 단일 파일로 결합하면 에서 읽고 에 쓸 수 있는 스토리지 장치로 사용할 수 있습니다. 블록 기반 스토리지 인터페이스는 다음과 같은 회전 미디어를 사용하여 데이터를 저장하는 가장 일반적인 방법입니다.

- 하드 드라이브

- CD/DVD 디스크

- 플로피 디스크

- 기존의 9개 트랙 테이프

블록 장치 인터페이스를 쉽게 사용할 경우 가상 블록 장치는 Red Hat Ceph Storage와 같은 대용량 데이터 스토리지 시스템과 상호 작용하는 데 이상적입니다.

Ceph 블록 장치는 Ceph 스토리지 클러스터에서 씬 프로비저닝, 크기 조정 및 저장 데이터가 여러 OSD(오브젝트 스토리지 장치)에서 스트라이핑됩니다. Ceph 블록 장치는 RADOS(Reliable Autonomic Distributed Object Store) 블록 장치(RBD)라고 합니다. Ceph 블록 장치는 다음과 같은 RADOS 기능을 활용합니다.

- 스냅샷

- 복제

- 데이터 일관성

Ceph 블록 장치는 librbd 라이브러리를 사용하여 OSD와 상호 작용합니다.

Ceph 블록 장치는 libvirt 및 QEMU 유틸리티를 사용하여 Ceph 블록 장치와 통합되는 OpenStack과 같은 클라우드 기반 컴퓨팅 시스템(QEMU)과 같은 KVM(커널 가상 시스템)에 무한 확장성과 함께 고성능을 제공합니다. 동일한 스토리지 클러스터를 사용하여 Ceph Object Gateway 및 Ceph 블록 장치를 동시에 작동할 수 있습니다.

Ceph 블록 장치를 사용하려면 실행 중인 Ceph 스토리지 클러스터에 액세스할 수 있어야 합니다. Red Hat Ceph Storage 클러스터 설치에 대한 자세한 내용은 Red Hat Ceph Storage 설치 가이드를 참조하십시오.

2장. Ceph 블록 장치

스토리지 관리자는 Ceph의 블록 장치 명령을 잘 알고 있으면 Red Hat Ceph Storage 클러스터를 효과적으로 관리할 수 있습니다. Ceph 블록 장치의 다양한 기능을 활성화 및 비활성화하는 것과 함께 블록 장치 풀과 이미지를 만들고 관리할 수 있습니다.

2.1. 사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

2.2. 명령 도움말 표시

명령줄 인터페이스에서 명령 및 하위 명령 온라인 도움말을 표시합니다.

h 옵션은 사용 가능한 모든 명령에 대한 도움말을 계속 표시합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

rbd help명령을 사용하여 특정rbd명령 및 해당 하위 명령에 대한 도움말을 표시합니다.구문

rbd help COMMAND SUBCOMMAND

rbd help COMMAND SUBCOMMANDCopy to Clipboard Copied! Toggle word wrap Toggle overflow snap list명령에 대한 도움말을 표시하려면 다음을 수행합니다.rbd help snap list

[root@rbd-client ~]# rbd help snap listCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. 블록 장치 풀 생성

블록 장치 클라이언트를 사용하기 전에 rbd 풀이 활성화되어 초기화되었는지 확인합니다.

풀을 소스로 지정하기 전에 먼저 생성해야 합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

rbd풀을 생성하려면 다음을 실행합니다.구문

ceph osd pool create POOL_NAME PG_NUM ceph osd pool application enable POOL_NAME rbd rbd pool init -p POOL_NAME

ceph osd pool create POOL_NAME PG_NUM ceph osd pool application enable POOL_NAME rbd rbd pool init -p POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

ceph osd pool create pool1 ceph osd pool application enable pool1 rbd rbd pool init -p pool1

[root@rbd-client ~]# ceph osd pool create pool1 [root@rbd-client ~]# ceph osd pool application enable pool1 rbd [root@rbd-client ~]# rbd pool init -p pool1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Storage Strategies Guide 의 Pools 장을 참조하십시오.

2.4. 블록 장치 이미지 생성

블록 장치를 노드에 추가하기 전에 Ceph 스토리지 클러스터에 블록 장치를 위한 이미지를 만듭니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

블록 장치 이미지를 생성하려면 다음 명령을 실행합니다.

구문

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd create image1 --size 1024 --pool pool1

[root@rbd-client ~]# rbd create image1 --size 1024 --pool pool1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 예제에서는 pool1 풀에 정보를 저장하는

image1이라는 1GB 이미지를 생성합니다.참고이미지를 생성하기 전에 풀이 있는지 확인합니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 블록 장치 가이드의 블록 장치풀 생성 섹션을 참조하십시오.

2.5. 블록 장치 이미지 나열

블록 장치 이미지를 나열합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

rbd풀의 블록 장치를 나열하려면 다음 명령을 실행합니다.참고rbd는 기본 풀 이름입니다.예제

rbd ls

[root@rbd-client ~]# rbd lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 특정 풀의 블록 장치를 나열하려면 다음을 수행합니다.

구문

rbd ls POOL_NAME

rbd ls POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd ls pool1

[root@rbd-client ~]# rbd ls pool1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6. 블록 장치 이미지 정보 검색

블록 장치 이미지에 대한 정보를 검색합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

기본

rbd풀의 특정 이미지에서 정보를 검색하려면 다음 명령을 실행합니다.구문

rbd --image IMAGE_NAME info

rbd --image IMAGE_NAME infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd --image image1 info

[root@rbd-client ~]# rbd --image image1 infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 풀 내에서 이미지 정보를 검색하려면 다음을 수행합니다.

구문

rbd --image IMAGE_NAME -p POOL_NAME info

rbd --image IMAGE_NAME -p POOL_NAME infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd --image image1 -p pool1 info

[root@rbd-client ~]# rbd --image image1 -p pool1 infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7. 블록 장치 이미지 크기 조정

Ceph 블록 장치 이미지는 씬 프로비저닝됩니다. 데이터 저장을 시작하기 전까지는 실제 스토리지를 사용하지 않습니다. 그러나 여기에는 --size 옵션으로 설정한 최대 용량이 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

기본

rbd풀의 Ceph 블록 장치 이미지의 최대 크기를 늘리려면 다음을 수행합니다.구문

rbd resize --image IMAGE_NAME --size SIZE

rbd resize --image IMAGE_NAME --size SIZECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd resize --image image1 --size 1024

[root@rbd-client ~]# rbd resize --image image1 --size 1024Copy to Clipboard Copied! Toggle word wrap Toggle overflow 기본

rbd풀의 Ceph 블록 장치 이미지의 최대 크기를 줄이려면 다음을 수행합니다.구문

rbd resize --image IMAGE_NAME --size SIZE --allow-shrink

rbd resize --image IMAGE_NAME --size SIZE --allow-shrinkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd resize --image image1 --size 1024 --allow-shrink

[root@rbd-client ~]# rbd resize --image image1 --size 1024 --allow-shrinkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 특정 풀의 Ceph 블록 장치 이미지의 최대 크기를 늘리려면 다음을 수행합니다.

구문

rbd resize --image POOL_NAME/IMAGE_NAME --size SIZE

rbd resize --image POOL_NAME/IMAGE_NAME --size SIZECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd resize --image pool1/image1 --size 1024

[root@rbd-client ~]# rbd resize --image pool1/image1 --size 1024Copy to Clipboard Copied! Toggle word wrap Toggle overflow 특정 풀의 Ceph 블록 장치 이미지의 최대 크기를 줄이려면 다음을 수행합니다.

구문

rbd resize --image POOL_NAME/IMAGE_NAME --size SIZE --allow-shrink

rbd resize --image POOL_NAME/IMAGE_NAME --size SIZE --allow-shrinkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd resize --image pool1/image1 --size 1024 --allow-shrink

[root@rbd-client ~]# rbd resize --image pool1/image1 --size 1024 --allow-shrinkCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.8. 블록 장치 이미지 제거

블록 장치 이미지를 제거합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

기본

rbd풀에서 블록 장치를 제거하려면 다음을 수행합니다.구문

rbd rm IMAGE_NAME

rbd rm IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd rm image1

[root@rbd-client ~]# rbd rm image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 특정 풀에서 블록 장치를 제거하려면 다음을 수행합니다.

구문

rbd rm IMAGE_NAME -p POOL_NAME

rbd rm IMAGE_NAME -p POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd rm image1 -p pool1

[root@rbd-client ~]# rbd rm image1 -p pool1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.9. 블록 장치 이미지를 휴지통으로 이동

RADOS 블록 장치(RBD) 이미지는 rbd 휴지통 명령을 사용하여 휴지통으로 이동할 수 있습니다. 이 명령은 rbd rm 명령보다 더 많은 옵션을 제공합니다.

이미지가 휴지통으로 이동되면 나중에 휴지통에서 제거할 수 있습니다. 이는 실수로 삭제되는 것을 방지하는 데 도움이 됩니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

이미지를 휴지통으로 이동하려면 다음을 실행합니다.

구문

rbd trash mv [POOL_NAME/] IMAGE_NAME

rbd trash mv [POOL_NAME/] IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd trash mv pool1/image1

[root@rbd-client ~]# rbd trash mv pool1/image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이미지가 휴지통에 있으면 고유 이미지 ID가 할당됩니다.

참고휴지 옵션을 사용해야 하는 경우 나중에 이미지를 지정하려면 이 이미지 ID가 필요합니다.

-

휴지통에 있는 이미지 ID 목록에 대해 rbd 휴지통 POOL_NAME을 실행합니다. 이 명령은 이미지의 사전 삭제 이름도 반환합니다. 또한rbd info 및 rbdsnap명령과 함께 사용할 수 있는 선택적--image-id인수가 있습니다.rbd info명령과 함께--image-id를 사용하여 휴지통의 이미지 속성을 확인하고rbd snap과 함께 사용하여 휴지통에서 이미지의 스냅샷을 제거합니다. 휴지통에서 이미지를 제거하려면 다음을 실행합니다.

구문

rbd trash rm [POOL_NAME/] IMAGE_ID

rbd trash rm [POOL_NAME/] IMAGE_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd trash rm pool1/d35ed01706a0

[root@rbd-client ~]# rbd trash rm pool1/d35ed01706a0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 중요휴지통에서 이미지를 제거한 후에는 복원할 수 없습니다.

이미지를

복원하려면 rbd 휴지통 복원명령을 실행합니다.구문

rbd trash restore [POOL_NAME/] IMAGE_ID

rbd trash restore [POOL_NAME/] IMAGE_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd trash restore pool1/d35ed01706a0

[root@rbd-client ~]# rbd trash restore pool1/d35ed01706a0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 휴지통에서 만료된 모든 이미지를 제거하려면 다음을 수행합니다.

구문

rbd trash purge POOL_NAME

rbd trash purge POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd trash purge pool1 Removing images: 100% complete...done.

[root@rbd-client ~]# rbd trash purge pool1 Removing images: 100% complete...done.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.10. 자동 삭제 일정 정의

풀에서 정기적인 휴지 삭제 작업을 예약할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

휴지 제거 일정을 추가하려면 다음을 실행합니다.

구문

rbd trash purge schedule add --pool POOL_NAME INTERVAL

rbd trash purge schedule add --pool POOL_NAME INTERVALCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# rbd trash purge schedule add --pool pool1 10m

[ceph: root@host01 /]# rbd trash purge schedule add --pool pool1 10mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 휴지 제거 일정을 나열하려면 다음을 실행합니다.

구문

rbd trash purge schedule ls --pool POOL_NAME

rbd trash purge schedule ls --pool POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# rbd trash purge schedule ls --pool pool1 every 10m

[ceph: root@host01 /]# rbd trash purge schedule ls --pool pool1 every 10mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 휴지 제거 일정의 상태를 확인하려면 다음을 실행합니다.

예제

[ceph: root@host01 /]# rbd trash purge schedule status POOL NAMESPACE SCHEDULE TIME pool1 2021-08-02 11:50:00

[ceph: root@host01 /]# rbd trash purge schedule status POOL NAMESPACE SCHEDULE TIME pool1 2021-08-02 11:50:00Copy to Clipboard Copied! Toggle word wrap Toggle overflow 휴지 제거 일정을 제거하려면 다음을 실행합니다.

구문

rbd trash purge schedule remove --pool POOL_NAME INTERVAL

rbd trash purge schedule remove --pool POOL_NAME INTERVALCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# rbd trash purge schedule remove --pool pool1 10m

[ceph: root@host01 /]# rbd trash purge schedule remove --pool pool1 10mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.11. 이미지 기능 활성화 및 비활성화

fast-diff, 과 같은 블록 장치 이미지는 기본적으로 활성화되어 있습니다. 기존 이미지에서 이러한 이미지 기능을 활성화하거나 비활성화할 수 있습니다.

exclusive- lock,object- map 또는 deep- flatten

심층 플랫 기능은 기존 이미지에서만 비활성화할 수 있지만 활성화되지는 않습니다. 심층 플랫 을 사용하려면 이미지를 만들 때 활성화합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

풀의 특정 이미지에서 정보를 검색합니다.

구문

rbd --image POOL_NAME/IMAGE_NAME info

rbd --image POOL_NAME/IMAGE_NAME infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# rbd --image pool1/image1 info

[ceph: root@host01 /]# rbd --image pool1/image1 infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 기능을 활성화합니다.

구문

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE_NAME

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow pool1

풀의기능을 활성화하려면 다음을 수행합니다.image1 이미지에서배타적 잠금예제

[ceph: root@host01 /]# rbd feature enable pool1/image1 exclusive-lock

[ceph: root@host01 /]# rbd feature enable pool1/image1 exclusive-lockCopy to Clipboard Copied! Toggle word wrap Toggle overflow 중요fast-diff 및기능을 활성화하면 오브젝트 맵을 다시 빌드합니다.object-map구문

rbd object-map rebuild POOL_NAME/IMAGE_NAME

rbd object-map rebuild POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow

기능을 비활성화합니다.

구문

rbd feature disable POOL_NAME/IMAGE_NAME FEATURE_NAME

rbd feature disable POOL_NAME/IMAGE_NAME FEATURE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow pool1 풀의

image1 이미지에서fast-diff기능을 비활성화하려면 다음을 수행합니다.예제

[ceph: root@host01 /]# rbd feature disable pool1/image1 fast-diff

[ceph: root@host01 /]# rbd feature disable pool1/image1 fast-diffCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.12. 이미지 메타데이터 작업

Ceph에서는 사용자 지정 이미지 메타데이터를 키-값 쌍으로 추가할 수 있습니다. 쌍에는 엄격한 형식이 없습니다.

또한 메타데이터를 사용하면 특정 이미지에 대한 RADOS 블록 장치(RBD) 구성 매개변수를 설정할 수 있습니다.

rbd image-meta 명령을 사용하여 메타데이터로 작업합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

새 메타데이터 키-값 쌍을 설정하려면 다음을 수행합니다.

구문

rbd image-meta set POOL_NAME/IMAGE_NAME KEY VALUE

rbd image-meta set POOL_NAME/IMAGE_NAME KEY VALUECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# rbd image-meta set pool1/image1 last_update 2021-06-06

[ceph: root@host01 /]# rbd image-meta set pool1/image1 last_update 2021-06-06Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 예제에서는

pool1 풀의image1 이미지의2021-06-06값으로last_update키를 설정합니다.키 값을 보려면 다음을 수행합니다.

구문

rbd image-meta get POOL_NAME/IMAGE_NAME KEY

rbd image-meta get POOL_NAME/IMAGE_NAME KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# rbd image-meta get pool1/image1 last_update

[ceph: root@host01 /]# rbd image-meta get pool1/image1 last_updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 예제에서는

last_update키 값을 봅니다.이미지의 모든 메타데이터를 표시하려면 다음을 수행합니다.

구문

rbd image-meta list POOL_NAME/IMAGE_NAME

rbd image-meta list POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# rbd image-meta list pool1/image1

[ceph: root@host01 /]# rbd image-meta list pool1/image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 예에서는

pool1 풀의image1이미지에 설정된 메타데이터를 나열합니다.메타데이터 키-값 쌍을 제거하려면 다음을 수행합니다.

구문

rbd image-meta remove POOL_NAME/IMAGE_NAME KEY

rbd image-meta remove POOL_NAME/IMAGE_NAME KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# rbd image-meta remove pool1/image1 last_update

[ceph: root@host01 /]# rbd image-meta remove pool1/image1 last_updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 예제에서는

pool1 풀의image1 이미지에서last_update키-값 쌍을 제거합니다.특정 이미지의 Ceph 구성 파일에 설정된 RBD 이미지 구성 설정을 재정의하려면 다음을 수행합니다.

구문

rbd config image set POOL_NAME/IMAGE_NAME PARAMETER VALUE

rbd config image set POOL_NAME/IMAGE_NAME PARAMETER VALUECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# rbd config image set pool1/image1 rbd_cache false

[ceph: root@host01 /]# rbd config image set pool1/image1 rbd_cache falseCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 예제에서는

pool1 풀에서image1이미지의 RBD 캐시를 비활성화합니다.

2.13. 풀 간에 이미지 이동

동일한 클러스터 내의 여러 풀 간에 RADOS 블록 장치(RBD) 이미지를 이동할 수 있습니다.

이 프로세스 중에 소스 이미지는 모든 스냅샷 기록이 포함된 대상 이미지에 복사되고, 선택적으로 스파스성 보존에 도움이 되도록 소스 이미지의 상위 항목에 대한 링크가 제공됩니다. 소스 이미지는 읽기 전용이며 대상 이미지는 쓸 수 있습니다. 마이그레이션이 진행되는 동안 대상 이미지는 소스 이미지에 연결됩니다.

새 대상 이미지가 사용 중인 동안 이 프로세스를 백그라운드로 안전하게 실행할 수 있습니다. 그러나 준비 단계 전에 대상 이미지를 사용하는 모든 클라이언트를 중지하여 새 대상 이미지를 가리키도록 이미지를 사용하는 클라이언트가 업데이트되었는지 확인합니다.

krbd 커널 모듈은 현재 실시간 마이그레이션을 지원하지 않습니다.

사전 요구 사항

- 소스 이미지를 사용하는 모든 클라이언트를 중지합니다.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

소스 및 대상 이미지를 교차 링크하는 새 대상 이미지를 생성하여 마이그레이션을 준비합니다.

구문

rbd migration prepare SOURCE_IMAGE TARGET_IMAGE

rbd migration prepare SOURCE_IMAGE TARGET_IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow 교체:

- 이동할 이미지의 이름이 SOURCE_IMAGE 입니다. POOL/IMAGE_NAME 형식을 사용합니다.

- 새 이미지의 이름으로 TARGET_IMAGE. POOL/IMAGE_NAME 형식을 사용합니다.

예제

rbd migration prepare pool1/image1 pool2/image2

[root@rbd-client ~]# rbd migration prepare pool1/image1 pool2/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 준비해야하는 새 대상 이미지의 상태를 확인합니다.구문

rbd status TARGET_IMAGE

rbd status TARGET_IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 선택적으로 새 대상 이미지 이름을 사용하여 클라이언트를 다시 시작합니다.

소스 이미지를 대상 이미지에 복사합니다.

구문

rbd migration execute TARGET_IMAGE

rbd migration execute TARGET_IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd migration execute pool2/image2

[root@rbd-client ~]# rbd migration execute pool2/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 마이그레이션이 완료되었는지 확인합니다.

예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 소스 이미지와 대상 이미지 간에 교차 링크를 제거하여 마이그레이션을 커밋하고 소스 이미지도 제거합니다.

구문

rbd migration commit TARGET_IMAGE

rbd migration commit TARGET_IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd migration commit pool2/image2

[root@rbd-client ~]# rbd migration commit pool2/image2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 소스 이미지가 하나 이상의 복제본의 상위인 경우 복제 이미지가 사용되지 않도록 한 후

--force옵션을 사용합니다.예제

rbd migration commit pool2/image2 --force

[root@rbd-client ~]# rbd migration commit pool2/image2 --forceCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 준비 단계 후 클라이언트를 재시작하지 않은 경우 새 대상 이미지 이름을 사용하여 클라이언트를 다시 시작합니다.

2.14. 풀 마이그레이션

RADOS Block Device(RBD) 이미지를 마이그레이션하거나 복사할 수 있습니다.

이 프로세스 중에 소스 이미지를 내보낸 다음 가져옵니다.

워크로드에 RBD 이미지 만 포함된 경우 이 마이그레이션 프로세스를 사용합니다. 워크로드에 rados cppool 이미지가 존재하지 않습니다. 워크로드에 rados cppool 이미지가 있는 경우 스토리지 전략 가이드에서 풀 마이그레이션 을 참조하십시오.

내보내기 및 가져오기 명령을 실행하는 동안 관련 RBD 이미지에 활성 I/O가 없는지 확인합니다. 이 풀 마이그레이션 시간 동안 프로덕션을 중단하는 것이 좋습니다.

사전 요구 사항

- 내보내기 및 가져올 RBD 이미지의 모든 활성 I/O를 중지합니다.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

볼륨을 마이그레이션합니다.

구문

rbd export volumes/VOLUME_NAME - | rbd import --image-format 2 - volumes_new/VOLUME_NAME

rbd export volumes/VOLUME_NAME - | rbd import --image-format 2 - volumes_new/VOLUME_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd export volumes/volume-3c4c63e3-3208-436f-9585-fee4e2a3de16 - | rbd import --image-format 2 - volumes_new/volume-3c4c63e3-3208-436f-9585-fee4e2a3de16

[root@rbd-client ~]# rbd export volumes/volume-3c4c63e3-3208-436f-9585-fee4e2a3de16 - | rbd import --image-format 2 - volumes_new/volume-3c4c63e3-3208-436f-9585-fee4e2a3de16Copy to Clipboard Copied! Toggle word wrap Toggle overflow 가져오기 또는 내보내기에 로컬 드라이브를 사용하는 경우 먼저 로컬 드라이브로 내보낸 다음 파일을 새 풀로 가져올 수 있습니다.

구문

rbd export volume/VOLUME_NAME FILE_PATH rbd import --image-format 2 FILE_PATH volumes_new/VOLUME_NAME

rbd export volume/VOLUME_NAME FILE_PATH rbd import --image-format 2 FILE_PATH volumes_new/VOLUME_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd export volumes/volume-3c4c63e3-3208-436f-9585-fee4e2a3de16 <path of export file> rbd import --image-format 2 <path> volumes_new/volume-3c4c63e3-3208-436f-9585-fee4e2a3de16

[root@rbd-client ~]# rbd export volumes/volume-3c4c63e3-3208-436f-9585-fee4e2a3de16 <path of export file> [root@rbd-client ~]# rbd import --image-format 2 <path> volumes_new/volume-3c4c63e3-3208-436f-9585-fee4e2a3de16Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.15. rbdmap 서비스

systemd 유닛 파일인 rbdmap.service 는 ceph-common 패키지에 포함되어 있습니다. rbdmap.service 장치는 rbdmap 쉘 스크립트를 실행합니다.

이 스크립트는 하나 이상의 RBD 이미지에 대한 RBD(RADOS 블록 장치) 매핑 및 매핑 해제를 자동화합니다. 스크립트는 언제든지 수동으로 실행할 수 있지만 일반적인 사용 사례는 부팅 시 RBD 이미지를 자동으로 마운트하고 종료 시 를 마운트 해제하는 것입니다. 이 스크립트는 RBD 이미지의 마운트를 해제하기 위해 할 수 있는 단일 인수를 사용합니다. 스크립트는 구성 파일을 구문 분석합니다. 기본값은 매핑 하거나 매핑 해제/etc/ceph/rbdmap 이지만 RBDMAPFILE 이라는 환경 변수를 사용하여 재정의할 수 있습니다. 구성 파일의 각 행은 RBD 이미지에 해당합니다.

구성 파일 형식의 형식은 다음과 같습니다.

IMAGE_SPEC RBD_OPTS

여기서 IMAGE_SPEC 는 POOL_NAME / IMAGE_NAME 또는 IMAGE_NAME 만 지정합니다. 이 경우 POOL_NAME 의 기본값은 rbd 입니다. RBD_OPTS 는 기본 rbd map 명령으로 전달할 옵션 목록입니다. 이러한 매개변수와 해당 값은 쉼표로 구분된 문자열로 지정해야 합니다.

OPT1=VAL1,OPT2=VAL2,…,OPT_N=VAL_N

이렇게 하면 스크립트에서 다음과 같이 rbd map 명령을 실행합니다.

구문

rbd map POOLNAME/IMAGE_NAME --OPT1 VAL1 --OPT2 VAL2

rbd map POOLNAME/IMAGE_NAME --OPT1 VAL1 --OPT2 VAL2쉼표 또는 등가 기호가 포함된 옵션과 값의 경우 간단한 apostrophe를 사용하여 교체하지 않도록 할 수 있습니다.

성공하면 rbd 맵 작업에서 이미지를 /dev/rbdX 장치에 매핑합니다. 이 장치에서 udev 규칙이 트리거되어 친숙한 장치 이름 symlink(예: /dev/rbd/POOL_NAME/IMAGE_NAME )가 실제 매핑된 장치를 가리킵니다. 마운트 또는 마운트 해제가 성공하려면 친숙한 장치 이름에 /etc/fstab 파일에 해당 항목이 있어야 합니다. RBD 이미지에 대한 /etc/fstab 항목을 작성할 때 noauto 또는 no fail 마운트 옵션을 지정하는 것이 좋습니다. 이렇게 하면 init 시스템이 장치가 존재하기 전에 장치를 너무 빨리 마운트하지 못하게 합니다.

2.16. rbdmap 서비스 구성

부팅 시 또는 각각 종료 시 RADOS 블록 장치(RBD)를 자동으로 매핑 및 마운트 해제합니다.

사전 요구 사항

- 마운트를 수행하는 노드에 대한 루트 수준 액세스입니다.

-

ceph-common패키지 설치.

절차

-

/etc/ceph/rbdmap구성 파일을 편집하기 위해 를 엽니다. RBD 이미지 또는 이미지를 구성 파일에 추가합니다.

예제

foo/bar1 id=admin,keyring=/etc/ceph/ceph.client.admin.keyring foo/bar2 id=admin,keyring=/etc/ceph/ceph.client.admin.keyring,options='lock_on_read,queue_depth=1024'

foo/bar1 id=admin,keyring=/etc/ceph/ceph.client.admin.keyring foo/bar2 id=admin,keyring=/etc/ceph/ceph.client.admin.keyring,options='lock_on_read,queue_depth=1024'Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 구성 파일에 변경 사항을 저장합니다.

RBD 매핑 서비스를 활성화합니다.

예제

systemctl enable rbdmap.service

[root@client ~]# systemctl enable rbdmap.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.17. 영구 쓰기 로그 캐시

캐시 장치로 SSD를 사용하는 PWL(영구 쓰기 로그)은 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원하지 않으며, 기능상 완전하지 않을 수 있어 프로덕션에 사용하지 않는 것이 좋습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다. 자세한 내용은 Red Hat 기술 프리뷰 기능에 대한 지원 범위를 참조하십시오.

Red Hat Ceph Storage 클러스터에서 PDWL(Persistent Write Log) 캐시는 librbd 기반 RBD 클라이언트에 대해 영구적인 내결함성 쓰기 캐시를 제공합니다.

PWL 캐시는 로그 주문 쓰기백 설계를 사용하여 내부적으로 검사점을 유지 관리하여 클러스터에 플러시되는 쓰기가 항상 일관되게 충돌합니다. 클라이언트 캐시가 완전히 손실되면 디스크 이미지가 계속 일관되지만 데이터가 부실하게 표시됩니다. PWL 캐시는 PDM(영구 메모리) 또는 SSD(솔리드 스테이트 디스크)와 함께 캐시 장치로 사용할 수 있습니다.

PMEM의 경우 캐시 모드는 복제본 쓰기 로그(RWL)이고 SSD의 경우 캐시 모드는 (SSD)입니다. 현재 PWL 캐시는 RWL 및 SSD 모드를 지원하며 기본적으로 비활성화되어 있습니다.

PWL 캐시의 주요 장점은 다음과 같습니다.

- PWL 캐시는 캐시가 가득 차 있지 않을 때 높은 성능을 제공할 수 있습니다. 캐시가 클수록 성능이 길어집니다.

- PWL 캐시는 지속성을 제공하며 RBD 캐시보다 훨씬 느리지 않습니다. RBD 캐시는 더 빠르지만 휘발성이며 데이터 순서 및 지속성을 보장할 수 없습니다.

- 캐시가 가득 차 있는 steady 상태에서 성능은 비행 중인 I/O 수의 영향을 받습니다. 예를 들어, PWL은 낮은 io_depth에서 더 높은 성능을 제공할 수 있지만 I/O 수가 32보다 클 때와 같이 높은 io_depth로 캐시가 없는 경우 성능이 저하되는 경우가 많습니다.

PMEM 캐싱 사용 사례는 다음과 같습니다.

- RBD 캐시와 다르면 PWL 캐시에는 비휘발성 특성이 있으며 데이터 손실을 원하지 않고 성능이 필요한 시나리오에서 사용됩니다.

- RWL 모드는 짧은 대기 시간을 제공합니다. 버스트 I/O에 대한 안정적인 짧은 대기 시간을 가지며 안정적인 짧은 대기 시간에 대한 높은 요구사항이 있는 시나리오에 적합합니다.

- RWL 모드는 또한 낮은 I/O 깊이가 있거나 너무 많은 inflight I/O가 없는 시나리오에서 높은 연속적이고 안정적인 성능 개선을 제공합니다.

SSD 캐싱 사용 사례는 다음과 같습니다.

- SSD 모드의 장점은 RWL 모드와 유사합니다. SSD 하드웨어는 상대적으로 저렴하고 인기가 있지만 성능은 PMEM보다 약간 낮습니다.

2.18. 영구 쓰기 로그 캐시 제한 사항

PWL(영구 쓰기 로그) 캐시를 사용하는 경우 고려해야 할 몇 가지 제한 사항이 있습니다.

- PMEM(영구 메모리) 및 SSD(Solid-state disks)의 기본 구현은 PMEM이 성능을 향상시킵니다. 현재 PMEM은 "쓰기 시"를 제공할 수 있으며 SSD는 "플러쉬 또는 검사점"입니다. 향후 릴리스에서는 이러한 두 가지 모드를 구성할 수 있습니다.

-

사용자가 자주적이고 열린 이미지를 반복해서 전환하면 Ceph에서 성능이 저하됩니다. PWL 캐시가 활성화된 경우 성능이 저하됩니다. flexible I/O(fio) 테스트에서

num_jobs를 설정하지 않는 대신 다른 이미지를 작성하도록 여러 작업을 설정합니다.

2.19. 영구 쓰기 로그 캐시 활성화

Ceph RADOS 블록 장치(RBD) rbd_persistent_cache_mode 및 rbd_plugins 옵션을 설정하여 Red Hat Ceph Storage 클러스터에서 PDL(영구 쓰기 캐시)을 활성화할 수 있습니다.

영구 쓰기 로그 캐시를 활성화하려면 exclusive-lock 기능을 활성화해야 합니다. 캐시는 배타적 잠금을 가져온 후에만 로드할 수 있습니다. rbd_default_features 구성 옵션 또는 rbd create 명령의 --image-feature 플래그로 재정의하지 않는 한 기본적으로 새로 생성된 이미지에서 exclusive-locks가 활성화됩니다. 독점 잠금 기능에 대한 자세한 내용은 이미지 기능 활성화 및 비활성화 섹션을 참조하십시오.

ceph config set 명령을 사용하여 호스트 수준에서 영구 쓰기 로그 캐시 옵션을 설정합니다. 풀 또는 이미지 수준에서 영구 쓰기 로그 캐시 옵션을 설정합니다. rbd 구성 풀 세트 또는 rbd 구성 이미지 세트 명령을 사용합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 모니터 노드에 대한 루트 수준 액세스입니다.

- exclusive-lock 기능을 사용할 수 있습니다.

- 클라이언트 측 디스크는 PDM(영구 메모리) 또는 SSD(Solid-state disks)입니다.

- RBD 캐시가 비활성화되어 있습니다.

절차

PWL 캐시를 활성화합니다.

호스트 수준에서

ceph config set명령을 사용합니다.구문

ceph config set client rbd_persistent_cache_mode CACHE_MODE ceph config set client rbd_plugins pwl_cache

ceph config set client rbd_persistent_cache_mode CACHE_MODE ceph config set client rbd_plugins pwl_cacheCopy to Clipboard Copied! Toggle word wrap Toggle overflow CACHE_MODE 를

rwl또는ssd로 바꿉니다.예제

[ceph: root@host01 /]# ceph config set client rbd_persistent_cache_mode ssd [ceph: root@host01 /]# ceph config set client rbd_plugins pwl_cache

[ceph: root@host01 /]# ceph config set client rbd_persistent_cache_mode ssd [ceph: root@host01 /]# ceph config set client rbd_plugins pwl_cacheCopy to Clipboard Copied! Toggle word wrap Toggle overflow 풀 수준에서

rbd 구성 풀 세트명령을 사용합니다.구문

rbd config pool set POOL_NAME rbd_persistent_cache_mode CACHE_MODE rbd config pool set POOL_NAME rbd_plugins pwl_cache

rbd config pool set POOL_NAME rbd_persistent_cache_mode CACHE_MODE rbd config pool set POOL_NAME rbd_plugins pwl_cacheCopy to Clipboard Copied! Toggle word wrap Toggle overflow CACHE_MODE 를

rwl또는ssd로 바꿉니다.예제

[ceph: root@host01 /]# rbd config pool set pool1 rbd_persistent_cache_mode ssd [ceph: root@host01 /]# rbd config pool set pool1 rbd_plugins pwl_cache

[ceph: root@host01 /]# rbd config pool set pool1 rbd_persistent_cache_mode ssd [ceph: root@host01 /]# rbd config pool set pool1 rbd_plugins pwl_cacheCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이미지 수준에서

rbd config image set명령을 사용합니다.구문

rbd config image set image set POOL_NAME/IMAGE_NAME rbd_persistent_cache_mode CACHE_MODE rbd config image set image set POOL_NAME/IMAGE_NAME rbd_plugins pwl_cache

rbd config image set image set POOL_NAME/IMAGE_NAME rbd_persistent_cache_mode CACHE_MODE rbd config image set image set POOL_NAME/IMAGE_NAME rbd_plugins pwl_cacheCopy to Clipboard Copied! Toggle word wrap Toggle overflow CACHE_MODE 를

rwl또는ssd로 바꿉니다.예제

[ceph: root@host01 /]# rbd config image set pool1/image1 rbd_persistent_cache_mode ssd [ceph: root@host01 /]# rbd config image set pool1/image1 rbd_plugins pwl_cache

[ceph: root@host01 /]# rbd config image set pool1/image1 rbd_persistent_cache_mode ssd [ceph: root@host01 /]# rbd config image set pool1/image1 rbd_plugins pwl_cacheCopy to Clipboard Copied! Toggle word wrap Toggle overflow

선택 사항: 호스트, 풀 또는 이미지 수준에서 RBD 옵션을 추가로 설정합니다.

구문

rbd_persistent_cache_mode CACHE_MODE rbd_plugins pwl_cache rbd_persistent_cache_path /PATH_TO_DAX_ENABLED_FOLDER/WRITE_BACK_CACHE_FOLDER rbd_persistent_cache_size PERSISTENT_CACHE_SIZE

rbd_persistent_cache_mode CACHE_MODE rbd_plugins pwl_cache rbd_persistent_cache_path /PATH_TO_DAX_ENABLED_FOLDER/WRITE_BACK_CACHE_FOLDER1 rbd_persistent_cache_size PERSISTENT_CACHE_SIZE2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- 1

rbd_persistent_cache_path- 성능 저하를 방지하기 위해rwl모드를 사용할 때 직접 액세스(DAX)를 활성화해야 하는 데이터를 캐시하는 파일 폴더입니다.- 2

rbd_persistent_cache_size- 최소 캐시 크기가 1GB인 이미지당 캐시 크기입니다. 캐시 크기가 클수록 성능이 향상됩니다.예제

rbd_cache false rbd_persistent_cache_mode rwl rbd_plugins pwl_cache rbd_persistent_cache_path /mnt/pmem/cache/ rbd_persistent_cache_size 1073741824

rbd_cache false rbd_persistent_cache_mode rwl rbd_plugins pwl_cache rbd_persistent_cache_path /mnt/pmem/cache/ rbd_persistent_cache_size 1073741824Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.20. 영구 쓰기 로그 캐시 상태 확인

영구 쓰기 로그(PWL) 캐시의 상태를 확인할 수 있습니다. 캐시는 배타적 잠금을 가져올 때 사용되며 배타적 잠금이 해제되면 영구 쓰기 로그 캐시가 닫힙니다. 캐시 상태는 캐시 크기, 위치, 유형 및 기타 캐시 관련 정보에 대한 정보를 표시합니다. 캐시 상태 업데이트는 캐시가 열리고 닫히면 수행됩니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 모니터 노드에 대한 루트 수준 액세스입니다.

- PWL 캐시가 활성화된 실행 중인 프로세스.

절차

PWL 캐시 상태 보기:

구문

rbd status POOL_NAME/IMAGE_NAME

rbd status POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.21. 영구 쓰기 로그 캐시 플러시

영구 쓰기 로그(PWL) 캐시를 삭제하기 전에 영구 캐시 플러시, 풀 이름 및 이미지 이름을 지정하여 캐시 파일을 rbd 명령으로 플러시할 수 있습니다. flush 명령은 캐시 파일을 OSD에 명시적으로 다시 쓸 수 있습니다. 캐시 중단이 있거나 애플리케이션이 예기치 않게 종료되면 캐시의 모든 항목이 OSD로 플러시되므로 데이터를 수동으로 플러시한 다음 캐시가 무효화 됩니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 모니터 노드에 대한 루트 수준 액세스입니다.

- PWL 캐시가 활성화되어 있습니다.

절차

PWL 캐시를 플러시합니다.

구문

rbd persistent-cache flush POOL_NAME/IMAGE_NAME

rbd persistent-cache flush POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# rbd persistent-cache flush pool1/image1

[ceph: root@host01 /]# rbd persistent-cache flush pool1/image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.22. 영구 쓰기 로그 캐시 삭제

캐시의 데이터가 만료된 경우 영구 쓰기 로그(PWL) 캐시를 수동으로 삭제해야 할 수 있습니다. rbd persistent-cache invalidate 명령을 사용하여 이미지의 캐시 파일을 삭제할 수 있습니다. 명령은 지정된 이미지의 캐시 메타데이터를 제거하고 캐시 기능을 비활성화한 다음 로컬 캐시 파일이 있는 경우 삭제합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 모니터 노드에 대한 루트 수준 액세스입니다.

- PWL 캐시가 활성화되어 있습니다.

절차

PWL 캐시 삭제:

구문

rbd persistent-cache invalidate POOL_NAME/IMAGE_NAME

rbd persistent-cache invalidate POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# rbd persistent-cache invalidate pool1/image1

[ceph: root@host01 /]# rbd persistent-cache invalidate pool1/image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.23. 명령줄 인터페이스를 사용하여 Ceph 블록 장치의 성능 모니터링

Red Hat Ceph Storage 4.1부터는 Ceph OSD 및 Manager 구성 요소 내에 성능 지표 수집 프레임워크가 통합됩니다. 이 프레임워크는 다른 Ceph 블록 장치 성능 모니터링 솔루션이 구축되는 성능 지표를 생성하고 처리할 수 있는 기본 방법을 제공합니다.

활성화된 경우 새 Ceph Manager 모듈인rbd_support 는 성능 지표를 집계합니다. rbd 명령에는 두 개의 새 작업( iotop 및 iostat )이 있습니다.

이러한 작업을 처음 사용하는 데 데이터 필드를 채우는 데 약 30초가 걸릴 수 있습니다.

사전 요구 사항

- Ceph 모니터 노드에 대한 사용자 수준 액세스.

절차

rbd_supportCeph Manager 모듈이 활성화되어 있는지 확인합니다.예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow "iotop" 이미지 스타일을 표시하려면 다음을 수행합니다.

예제

rbd perf image iotop

[user@mon ~]$ rbd perf image iotopCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고오른쪽 및 왼쪽 화살표 키를 사용하여 쓰기 ops, read-ops, write-bytes, read-latency 및 read-latency 열을 동적으로 정렬할 수 있습니다.

"iostat" 이미지 스타일을 표시하려면 다음을 수행합니다.

예제

rbd perf image iostat

[user@mon ~]$ rbd perf image iostatCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고이 명령의 출력은 JSON 또는 XML 형식일 수 있으며 다른 명령줄 툴을 사용하여 정렬할 수 있습니다.

2.24. 추가 리소스

-

매핑 및 매핑 해제에 대한 자세한 내용은 8장.

rbd커널 모듈 을 참조하십시오.

3장. 이미지 실시간 마이그레이션

스토리지 관리자는 스토리지 클러스터 내에서 여러 풀 또는 동일한 풀에서 RBD 이미지를 실시간 마이그레이션할 수 있습니다. 다양한 이미지 형식과 레이아웃 간에 마이그레이션할 수 있으며 외부 데이터 소스에서도 마이그레이션할 수 있습니다. 실시간 마이그레이션이 시작되면 소스 이미지가 대상 이미지에 깊이 복사되고 모든 스냅샷 기록을 가져와 가능한 데이터의 스파스 할당을 유지합니다.

현재 krbd 커널 모듈은 실시간 마이그레이션을 지원하지 않습니다.

3.1. 사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

3.2. 실시간 마이그레이션 프로세스

기본적으로 동일한 스토리지 클러스터를 사용하는 RBD 이미지를 실시간 마이그레이션하는 동안 소스 이미지는 읽기 전용으로 표시됩니다. 모든 클라이언트는 Input/Output(I/O)을 새 대상 이미지로 리디렉션합니다. 또한 이 모드에서는 소스 이미지의 상위 항목에 대한 링크를 유지하여 스파스성을 보존하거나 마이그레이션 중에 이미지를 병합하여 소스 이미지의 상위 항목에 대한 종속성을 제거할 수 있습니다. 소스 이미지가 변경되지 않은 가져오기 전용 모드에서 실시간 마이그레이션 프로세스를 사용할 수 있습니다. 백업 파일, HTTP 파일 또는 S3 오브젝트와 같은 외부 데이터 소스에 대상 이미지를 연결할 수 있습니다. 새 대상 이미지를 사용하는 동안 실시간 마이그레이션 복사 프로세스를 백그라운드에서 안전하게 실행할 수 있습니다.

실시간 마이그레이션 프로세스는 다음 세 단계로 구성됩니다.

마이그레이션 준비: 첫 번째 단계는 새 대상 이미지를 생성하고 대상 이미지를 소스 이미지에 연결하는 것입니다. 가져오기 전용 모드가 구성되지 않은 경우 소스 이미지도 대상 이미지에 연결되고 읽기 전용으로 표시됩니다. 대상 이미지 내에서 초기화되지 않은 데이터 익스텐트를 읽으려는 시도는 내부적으로 소스 이미지로 읽기를 리디렉션하고, 대상 이미지 내의 초기화되지 않은 확장 영역에 쓰기는 내부적으로 복사되고, 중복되는 소스 이미지 확장 영역이 대상 이미지에 포함됩니다.

마이그레이션 실행: 이 작업은 소스 이미지에서 대상으로 초기화된 모든 블록을 심층적으로 복사하는 백그라운드 작업입니다. 클라이언트가 새 대상 이미지를 적극적으로 사용하는 경우 이 단계를 실행할 수 있습니다.

마이그레이션 완료: 백그라운드 마이그레이션 프로세스가 완료되면 마이그레이션을 커밋하거나 중단할 수 있습니다. 마이그레이션을 커밋하면 소스 이미지와 대상 이미지 간의 교차 링크가 제거되고 가져오기 전용 모드에 구성되지 않은 경우 소스 이미지가 제거됩니다. 마이그레이션을 중단하면 교차 링크가 제거되고 대상 이미지가 제거됩니다.

3.3. 형식

기본 형식을 사용하여 Red Hat Ceph Storage 클러스터 내의 기본 RBD 이미지를 소스 이미지로 설명할 수 있습니다. source-spec JSON 문서는 다음과 같이 인코딩됩니다.

구문

기본 형식에는 기본 Ceph 작업을 활용하므로 스트림 오브젝트가 포함되지 않습니다. 예를 들어 이미지 rbd/ns1/image1@snap1 에서 가져오려면 source-spec 을 다음과 같이 인코딩할 수 있습니다.

예제

qcow 형식을 사용하여 QEMU COW(QCOW) 블록 장치를 설명할 수 있습니다. QCOW v1 및 v2 형식은 현재 압축, 암호화, 백업 파일, 외부 데이터 파일 등의 고급 기능을 제외하고 현재 지원됩니다. 지원되는 모든 스트림 소스에 qcow 형식 데이터를 연결할 수 있습니다.

예제

원시 형식을 사용하여 rbd 내보내기 -export-format 1 SNAP_SPEC인 씩 프로비저닝된 원시 블록 장치 내보내기 를 설명할 수 있습니다. 지원되는 모든 스트림 소스에 원시 형식 데이터를 연결할 수 있습니다.

예제

snapshot 배열 의 포함은 선택 사항이며 현재 씩 프로비저닝된 원시 스냅샷 내보내기만 지원합니다.

3.4. 스트림

파일 스트림

파일 스트림을 사용하여 로컬에서 액세스할 수 있는 POSIX 파일 소스에서 가져올 수 있습니다.

구문

예를 들어 /mnt/image.raw에 있는 파일에서 원시 형식 이미지를 가져오려면

source-spec JSON 파일은 다음과 같습니다.

예제

HTTP 스트림

HTTP 스트림을 사용하여 원격 HTTP 또는 HTTPS 웹 서버에서 가져올 수 있습니다.

구문

예를 들어, http://download.ceph.com/image.raw 에 있는 파일에서 원시 형식 이미지를 가져오려면 source-spec JSON 파일은 다음과 같습니다.

예제

S3 스트림

s3 스트림을 사용하여 원격 S3 버킷에서 가져올 수 있습니다.

구문

예를 들어 http://s3.ceph.com/bucket/image.raw 에 있는 파일에서 원시 형식 이미지를 가져오려면 source-spec JSON은 다음과 같이 인코딩됩니다.

예제

3.5. 실시간 마이그레이션 프로세스 준비

동일한 Red Hat Ceph Storage 클러스터 내에서 RBD 이미지에 대한 기본 실시간 마이그레이션 프로세스를 준비할 수 있습니다. rbd migration prepare 명령은 rbd create 명령과 동일한 레이아웃 옵션을 모두 허용합니다. rbd create 명령을 사용하면 변경 불가능한 이미지의 디스크 레이아웃을 변경할 수 있습니다. 디스크에 있는 레이아웃만 변경하고 원래 이미지 이름을 유지하려면 migration_target 인수를 건너뜁니다. 실시간 마이그레이션을 준비하기 전에 소스 이미지를 사용하는 모든 클라이언트를 중지해야 합니다. 읽기/쓰기 모드로 열린 이미지가 있는 실행 중인 클라이언트를 발견하면 prepare 단계가 실패합니다. 준비 단계가 완료되면 새 대상 이미지를 사용하여 클라이언트를 다시 시작할 수 있습니다.

소스 이미지를 사용하여 클라이언트를 재시작할 수 없으므로 실패합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 블록 장치 풀 두 개.

- 블록 장치 이미지 1개.

절차

스토리지 클러스터 내에서 실시간 마이그레이션을 준비합니다.

구문

rbd migration prepare SOURCE_POOL_NAME/SOURCE_IMAGE_NAME TARGET_POOL_NAME/SOURCE_IMAGE_NAME

rbd migration prepare SOURCE_POOL_NAME/SOURCE_IMAGE_NAME TARGET_POOL_NAME/SOURCE_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@rbd-client /]# rbd migration prepare sourcepool1/sourceimage1 targetpool1/sourceimage1

[ceph: root@rbd-client /]# rbd migration prepare sourcepool1/sourceimage1 targetpool1/sourceimage1Copy to Clipboard Copied! Toggle word wrap Toggle overflow OR

소스 이미지의 이름을 바꾸려면 다음을 수행합니다.

구문

rbd migration prepare SOURCE_POOL_NAME/SOURCE_IMAGE_NAME TARGET_POOL_NAME/NEW_SOURCE_IMAGE_NAME

rbd migration prepare SOURCE_POOL_NAME/SOURCE_IMAGE_NAME TARGET_POOL_NAME/NEW_SOURCE_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@rbd-client /]# rbd migration prepare sourcepool1/sourceimage1 targetpool1/newsourceimage1

[ceph: root@rbd-client /]# rbd migration prepare sourcepool1/sourceimage1 targetpool1/newsourceimage1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 예제에서

newsourceimage1은 이름이 변경된 소스 이미지입니다.다음 명령을 사용하여 실시간 마이그레이션 프로세스의 현재 상태를 확인할 수 있습니다.

구문

rbd status TARGET_POOL_NAME/SOURCE_IMAGE_NAME

rbd status TARGET_POOL_NAME/SOURCE_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 중요마이그레이션 프로세스 중에 잘못된 사용량을 방지하기 위해 소스 이미지가 RBD 휴지통으로 이동됩니다.

예제

[ceph: root@rbd-client /]# rbd info sourceimage1 rbd: error opening image sourceimage1: (2) No such file or directory

[ceph: root@rbd-client /]# rbd info sourceimage1 rbd: error opening image sourceimage1: (2) No such file or directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@rbd-client /]# rbd trash ls --all sourcepool1 adb429cb769a sourceimage1

[ceph: root@rbd-client /]# rbd trash ls --all sourcepool1 adb429cb769a sourceimage1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6. 가져오기 전용 마이그레이션 준비

--import 전용 실시간 마이그레이션 프로세스를 시작할 수 있으며 명령줄 또는 파일에서 직접 소스 이미지 데이터에 액세스하는 방법을 설명하는 JSON 문서를 전달할 수 있습니다.

-only 및 --source-spec 또는 옵션을 사용하여 --source- pathspec- rbd 마이그레이션 prepare 명령을 실행하여 가져오기

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 버킷과 S3 오브젝트가 생성됩니다.

절차

JSON 파일을 생성합니다.

예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 가져오기 전용 실시간마이그레이션 프로세스를 준비합니다.구문

rbd migration prepare --import-only --source-spec-path "JSON_FILE" TARGET_POOL_NAME

rbd migration prepare --import-only --source-spec-path "JSON_FILE" TARGET_POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@rbd-client /]# rbd migration prepare --import-only --source-spec-path "testspec.json" targetpool1

[ceph: root@rbd-client /]# rbd migration prepare --import-only --source-spec-path "testspec.json" targetpool1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고rbd migration prepare명령은rbd create명령과 동일한 이미지 옵션을 모두 허용합니다.가져오기 전용 실시간마이그레이션의 상태를 확인할 수 있습니다.예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.7. 실시간 마이그레이션 프로세스 실행

실시간 마이그레이션을 준비한 후 소스 이미지의 이미지 블록을 대상 이미지로 복사해야 합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 블록 장치 풀 두 개.

- 블록 장치 이미지 1개.

절차

실시간 마이그레이션을 실행합니다.

구문

rbd migration execute TARGET_POOL_NAME/SOURCE_IMAGE_NAME

rbd migration execute TARGET_POOL_NAME/SOURCE_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@rbd-client /]# rbd migration execute targetpool1/sourceimage1 Image migration: 100% complete...done.

[ceph: root@rbd-client /]# rbd migration execute targetpool1/sourceimage1 Image migration: 100% complete...done.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 마이그레이션 블록 심층 복사 프로세스의 진행 상태에 대한 피드백을 확인할 수 있습니다.

구문

rbd status TARGET_POOL_NAME/SOURCE_IMAGE_NAME

rbd status TARGET_POOL_NAME/SOURCE_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.8. 실시간 마이그레이션 프로세스 커밋

실시간 마이그레이션이 소스 이미지에서 대상 이미지로 모든 데이터 블록을 복사한 후 마이그레이션을 커밋할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 블록 장치 풀 두 개.

- 블록 장치 이미지 1개.

절차

마이그레이션을 커밋하면 심도 있는 복사가 완료됩니다.

구문

rbd migration commit TARGET_POOL_NAME/SOURCE_IMAGE_NAME

rbd migration commit TARGET_POOL_NAME/SOURCE_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@rbd-client /]# rbd migration commit targetpool1/sourceimage1 Commit image migration: 100% complete...done.

[ceph: root@rbd-client /]# rbd migration commit targetpool1/sourceimage1 Commit image migration: 100% complete...done.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

실시간 마이그레이션을 커밋하면 소스 이미지와 대상 이미지 간에 교차 링크가 제거되고 소스 풀에서 소스 이미지도 제거됩니다.

예제

[ceph: root@rbd-client /]# rbd trash list --all sourcepool1

[ceph: root@rbd-client /]# rbd trash list --all sourcepool13.9. 실시간 마이그레이션 프로세스 중단

실시간 마이그레이션 프로세스를 되돌릴 수 있습니다. 실시간 마이그레이션을 중단하면 준비 및 실행 단계를 되돌립니다.

실시간 마이그레이션을 커밋하지 않은 경우에만 중단할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 블록 장치 풀 두 개.

- 블록 장치 이미지 1개.

절차

실시간 마이그레이션 프로세스를 중단합니다.

구문

rbd migration abort TARGET_POOL_NAME/SOURCE_IMAGE_NAME

rbd migration abort TARGET_POOL_NAME/SOURCE_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@rbd-client /]# rbd migration abort targetpool1/sourceimage1 Abort image migration: 100% complete...done.

[ceph: root@rbd-client /]# rbd migration abort targetpool1/sourceimage1 Abort image migration: 100% complete...done.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

실시간 마이그레이션 프로세스가 중단되면 대상 이미지가 삭제되고 소스 풀에서 원본 소스 이미지에 대한 액세스가 복원됩니다.

예제

[ceph: root@rbd-client /]# rbd ls sourcepool1 sourceimage1

[ceph: root@rbd-client /]# rbd ls sourcepool1

sourceimage14장. 이미지 암호화

스토리지 관리자는 특정 RBD 이미지를 암호화하는 데 사용되는 비밀 키를 설정할 수 있습니다. 이미지 수준 암호화는 RBD 클라이언트가 내부적으로 처리합니다.

krbd 모듈은 이미지 수준 암호화를 지원하지 않습니다.

dm-crypt 또는 QEMU 와 같은 외부 툴을 사용하여 RBD 이미지를 암호화할 수 있습니다.

4.1. 사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 5 클러스터.

-

루트수준 권한.

4.2. 암호화 형식

RBD 이미지는 기본적으로 암호화되지 않습니다. 지원되는 암호화 형식 중 하나로 포맷하여 RBD 이미지를 암호화할 수 있습니다. 형식 작업은 암호화 메타데이터를 RBD 이미지에 유지합니다. 암호화 메타데이터에는 암호화 형식 및 버전, 암호 알고리즘 및 모드 사양 등의 정보와 암호화 키를 보호하는 데 사용되는 정보가 포함됩니다.

암호화 키는 사용자가 암호인 비밀을 유지하며 RBD 이미지에 영구 데이터로 저장되지 않습니다. 암호화 형식 작업을 수행하려면 암호화 형식, 암호 알고리즘 및 모드 사양과 암호를 지정해야 합니다. 암호화 메타데이터는 현재 RBD 이미지에 저장되며, 현재 원시 이미지 시작 시 작성된 암호화 헤더로 저장됩니다. 즉, 암호화된 이미지의 유효 이미지 크기가 원시 이미지 크기보다 낮아집니다.

명시적으로 포맷되지 않는 한 암호화된 이미지의 복제본은 본질적으로 동일한 형식과 시크릿을 사용하여 암호화됩니다.

스토리지 리소스를 차지할 수도 있지만 포맷하기 전에 RBD 이미지에 작성된 데이터는 읽을 수 없게 될 수 있습니다. 저널 기능이 활성화된 RBD 이미지는 암호화할 수 없습니다.

4.3. 암호화 로드

기본적으로 모든 RBD API는 암호화된 RBD 이미지를 암호화되지 않은 RBD 이미지와 동일한 방식으로 처리합니다. 이미지의 모든 위치에서 원시 데이터를 읽거나 쓸 수 있습니다. 원시 데이터를 이미지에 작성하면 암호화 형식의 무결성이 발생할 수 있습니다. 예를 들어 원시 데이터는 이미지 시작 부분에 있는 암호화 메타데이터를 재정의할 수 있습니다. 암호화된 RBD 이미지에서 암호화된 입력/출력(I/O) 또는 유지 관리 작업을 안전하게 수행하려면 이미지를 연 직후 추가 암호화 로드 작업을 적용해야 합니다.

암호화 로드 작업을 수행하려면 이미지 자체와 명시적으로 포맷된 각 이미지의 암호화 키 잠금을 해제하기 위한 암호와 암호화 형식을 지정해야 합니다. 열린 RBD 이미지의 모든 I/O는 암호화되거나 암호 해독됩니다. 복제된 RBD 이미지의 경우 상위 이미지의 IO가 포함됩니다. 암호화 키는 이미지가 닫힐 때까지 RBD 클라이언트에 의해 메모리에 저장됩니다.

RBD 이미지에 암호화가 로드되면 다른 암호화 로드 또는 형식 작업을 적용할 수 없습니다. 또한 열린 이미지 컨텍스트를 사용하여 RBD 이미지 크기 및 상위 중복을 검색하는 API 호출은 유효한 이미지 크기와 유효 상위 중첩을 각각 반환합니다. rbd-nbd 를 통해 RBD 이미지를 블록 장치로 매핑할 때 암호화가 자동으로 로드됩니다.

열린 이미지 컨텍스트를 사용하여 이미지 크기를 검색하고 상위 겹치는 API 호출은 유효한 이미지 크기와 유효 상위 중첩을 반환합니다.

암호화된 이미지의 복제본이 명시적으로 포맷된 경우, 상위 스냅샷에서 복사될 때 복제된 이미지 형식에 따라 상위 데이터를 다시 암호화해야 하므로 복제된 이미지의 복제본이 명시적으로 포맷되거나 축소됩니다. flatten 작업이 실행되기 전에 암호화가 로드되지 않으면 복제된 이미지에서 이전에 액세스할 수 있는 모든 상위 데이터가 읽을 수 없게 될 수 있습니다.

암호화된 이미지의 복제본이 명시적으로 포맷되면 복제된 이미지를 축소하는 작업이 투명하지 않습니다. 스냅샷을 포함하는 복제된 이미지 또는 복제된 이미지가 오브젝트 크기에 정렬되지 않는 크기로 축소되는 경우, 플랫과 유사하게 상위 스냅샷에서 일부 데이터를 복사하는 작업으로 축소되기 때문입니다. 축소 작업을 실행하기 전에 암호화를 로드하지 않으면 복제된 이미지에서 이전에 액세스할 수 있는 모든 상위 데이터가 읽을 수 없게 될 수 있습니다.

4.4. 지원되는 형식

Linux 통합 키 설정(LUKS) 1 및 2가 모두 지원됩니다. 데이터 레이아웃은 LUKS 사양과 완벽하게 호환됩니다. dm-crypt 또는 QEMU 와 같은 외부 LUKS 호환 툴은 암호화된 RBD 이미지에서 암호화된 입/출력(I/O)을 안전하게 수행할 수 있습니다. 또한 원시 LUKS 데이터를 RBD 이미지로 복사하여 외부 툴에서 만든 기존 LUKS 이미지를 가져올 수 있습니다.

현재 AES(Advanced Encryption Standards) 128 및 256 암호화 알고리즘만 지원됩니다. xts-plain64는 현재 유일하게 지원되는 암호화 모드입니다.

LUKS 형식을 사용하려면 다음 명령으로 RBD 이미지를 포맷합니다.

passphrase.txt 라는 파일을 생성하고 암호를 입력해야 합니다. 임의로 NULL 문자를 포함할 수 있는 암호를 생성할 수 있습니다. 암호가 줄 바꿈 문자로 종료되면 암호가 제거됩니다.

구문

rbd encryption format POOL_NAME/LUKS_IMAGE luks1|luks2 PASSPHRASE_FILE

rbd encryption format POOL_NAME/LUKS_IMAGE luks1|luks2 PASSPHRASE_FILE예제

[ceph: root@host01 /]# rbd encryption format pool1/luksimage1 luks1 passphrase.bin

[ceph: root@host01 /]# rbd encryption format pool1/luksimage1 luks1 passphrase.bin

luks1 또는 luks 암호화 형식을 선택할 수 있습니다.

암호화 형식 작업은 LUKS 헤더를 생성하고 RBD 이미지 시작 시 씁니다. 단일 키 슬롯이 헤더에 추가됩니다. keylot은 임의로 생성된 암호화 키를 보유하며 암호 파일에서 읽은 암호로 보호됩니다. 기본적으로 현재 권장 모드이며 다른 LUKS 도구의 기본값인 xts-plain64 모드의 AES-256이 사용됩니다. 현재 암호 추가 또는 제거는 기본적으로 지원되지 않지만 cryptsetup 과 같은 LUKS 도구를 사용하여 수행할 수 있습니다. LUKS 헤더 크기는 LUKS에서 최대 136MiB까지 다를 수 있지만, 일반적으로 설치된 libcryptsetup 버전에 따라 최대 16MiB입니다. 최적의 성능을 위해 암호화 형식은 데이터 오프셋을 이미지 오브젝트 크기와 정렬하도록 설정합니다. 예를 들어 8MiB 오브젝트 크기로 구성된 이미지를 사용하는 경우 최소 오버헤드가 8MiB여야 합니다.

LUKS1에서 최소 암호화 단위인 섹터는 512바이트로 고정됩니다. LUKS2는 대규모 섹터를 지원하며 더 나은 성능을 위해 기본 섹터 크기가 최대 4KiB로 설정됩니다. 섹터보다 작거나 섹터 시작에 맞지 않는 쓰기 작업 체인은 클라이언트에 보호되는 읽기-수정-쓰기 체인을 트리거하여 대기 시간이 크게 저하됩니다. 이러한 정렬되지 않은 쓰기 일괄 처리로 인해 I/O 경합이 발생할 수 있으므로 성능이 더욱 저하될 수 있습니다. Red Hat은 들어오는 쓰기가 LUKS 섹터가 정렬되도록 보장할 수 없는 경우 RBD 암호화를 사용하지 않는 것이 좋습니다.

LUKS 암호화된 이미지를 매핑하려면 다음 명령을 실행합니다.

구문

rbd device map -t nbd -o encryption-format=luks1|luks2,encryption-passphrase-file=passphrase.txt POOL_NAME/LUKS_IMAGE

rbd device map -t nbd -o encryption-format=luks1|luks2,encryption-passphrase-file=passphrase.txt POOL_NAME/LUKS_IMAGE예제

[ceph: root@host01 /]# rbd device map -t nbd -o encryption-format=luks1,encryption-passphrase-file=passphrase.txt pool1/luksimage1

[ceph: root@host01 /]# rbd device map -t nbd -o encryption-format=luks1,encryption-passphrase-file=passphrase.txt pool1/luksimage1

luks1 또는 luks 2 암호화 형식을 선택할 수 있습니다.

보안상의 이유로 암호화 형식과 암호화 로드 작업 모두 CPU 집약적이며 완료하는 데 몇 초가 걸릴 수 있습니다. 암호화된 I/O의 경우 AES-NI가 활성화되어 있다고 가정하면 상대적으로 작은 마이크로초 대기 시간이 추가되고 CPU 사용률이 다소 증가할 수 있습니다.

4.5. 이미지 및 복제에 암호화 형식 추가

계층화된 클라이언트 측 암호화가 지원됩니다. 복제된 이미지는 상위 이미지의 형식과 잠재적으로 다를 수 있는 자체 형식과 암호를 사용하여 암호화할 수 있습니다.

rbd 암호화 형식 명령을 사용하여 이미지 및 복제본에 암호화 형식을 추가합니다. LUKS2 형식의 이미지에 따라 LUKS2 형식의 복제본과 LUKS1 형식 복제를 둘 다 생성할 수 있습니다.

사전 요구 사항

- RBD(Block Device)가 구성된 실행 중인 Red Hat Ceph Storage 클러스터입니다.

- 노드에 대한 루트 수준 액세스.

절차

LUKS2 형식의 이미지를 생성합니다.

구문

rbd create --size SIZE POOL_NAME/LUKS_IMAGE rbd encryption format POOL_NAME/LUKS_IMAGE luks1|luks2 PASSPHRASE_FILE rbd resize --size 50G --encryption-passphrase-file PASSPHRASE_FILE POOL_NAME/LUKS_IMAGE

rbd create --size SIZE POOL_NAME/LUKS_IMAGE rbd encryption format POOL_NAME/LUKS_IMAGE luks1|luks2 PASSPHRASE_FILE rbd resize --size 50G --encryption-passphrase-file PASSPHRASE_FILE POOL_NAME/LUKS_IMAGECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# rbd create --size 50G mypool/myimage [ceph: root@host01 /]# rbd encryption format mypool/myimage luks2 passphrase.txt [ceph: root@host01 /]# rbd resize --size 50G --encryption-passphrase-file passphrase.txt mypool/myimage

[ceph: root@host01 /]# rbd create --size 50G mypool/myimage [ceph: root@host01 /]# rbd encryption format mypool/myimage luks2 passphrase.txt [ceph: root@host01 /]# rbd resize --size 50G --encryption-passphrase-file passphrase.txt mypool/myimageCopy to Clipboard Copied! Toggle word wrap Toggle overflow rbd 크기 조정명령은 LUKS2 헤더와 연결된 오버헤드를 보완하기 위해 이미지를 늘립니다.LUKS2 형식의 이미지를 사용하여 동일한 유효 크기로 LUKS2 형식의 복제를 생성합니다.

구문

rbd snap create POOL_NAME/IMAGE_NAME@SNAP_NAME rbd snap protect POOL_NAME/IMAGE_NAME@SNAP_NAME rbd clone POOL_NAME/IMAGE_NAME@SNAP_NAME POOL_NAME/CLONE_NAME rbd encryption format POOL_NAME/CLONE_NAME luks1 CLONE_PASSPHRASE_FILE

rbd snap create POOL_NAME/IMAGE_NAME@SNAP_NAME rbd snap protect POOL_NAME/IMAGE_NAME@SNAP_NAME rbd clone POOL_NAME/IMAGE_NAME@SNAP_NAME POOL_NAME/CLONE_NAME rbd encryption format POOL_NAME/CLONE_NAME luks1 CLONE_PASSPHRASE_FILECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# rbd snap create mypool/myimage@snap [ceph: root@host01 /]# rbd snap protect mypool/myimage@snap [ceph: root@host01 /]# rbd clone mypool/myimage@snap mypool/myclone [ceph: root@host01 /]# rbd encryption format mypool/myclone luks1 clone-passphrase.bin

[ceph: root@host01 /]# rbd snap create mypool/myimage@snap [ceph: root@host01 /]# rbd snap protect mypool/myimage@snap [ceph: root@host01 /]# rbd clone mypool/myimage@snap mypool/myclone [ceph: root@host01 /]# rbd encryption format mypool/myclone luks1 clone-passphrase.binCopy to Clipboard Copied! Toggle word wrap Toggle overflow LUKS2 형식 이미지를 사용하여 다음과 같은 효과적인 크기로 LUKS1 형식 복제를 생성합니다.

구문

rbd snap create POOL_NAME/IMAGE_NAME@SNAP_NAME rbd snap protect POOL_NAME/IMAGE_NAME@SNAP_NAME rbd clone POOL_NAME/IMAGE_NAME@SNAP_NAME POOL_NAME/CLONE_NAME rbd encryption format POOL_NAME/CLONE_NAME luks1 CLONE_PASSPHRASE_FILE rbd resize --size SIZE --allow-shrink --encryption-passphrase-file CLONE_PASSPHRASE_FILE --encryption-passphrase-file PASSPHRASE_FILE POOL_NAME/CLONE_NAME

rbd snap create POOL_NAME/IMAGE_NAME@SNAP_NAME rbd snap protect POOL_NAME/IMAGE_NAME@SNAP_NAME rbd clone POOL_NAME/IMAGE_NAME@SNAP_NAME POOL_NAME/CLONE_NAME rbd encryption format POOL_NAME/CLONE_NAME luks1 CLONE_PASSPHRASE_FILE rbd resize --size SIZE --allow-shrink --encryption-passphrase-file CLONE_PASSPHRASE_FILE --encryption-passphrase-file PASSPHRASE_FILE POOL_NAME/CLONE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# rbd snap create mypool/myimage@snap [ceph: root@host01 /]# rbd snap protect mypool/myimage@snap [ceph: root@host01 /]# rbd clone mypool/myimage@snap mypool/myclone [ceph: root@host01 /]# rbd encryption format mypool/myclone luks1 clone-passphrase.bin [ceph: root@host01 /]# rbd resize --size 50G --allow-shrink --encryption-passphrase-file clone-passphrase.bin --encryption-passphrase-file passphrase.bin mypool/myclone

[ceph: root@host01 /]# rbd snap create mypool/myimage@snap [ceph: root@host01 /]# rbd snap protect mypool/myimage@snap [ceph: root@host01 /]# rbd clone mypool/myimage@snap mypool/myclone [ceph: root@host01 /]# rbd encryption format mypool/myclone luks1 clone-passphrase.bin [ceph: root@host01 /]# rbd resize --size 50G --allow-shrink --encryption-passphrase-file clone-passphrase.bin --encryption-passphrase-file passphrase.bin mypool/mycloneCopy to Clipboard Copied! Toggle word wrap Toggle overflow LUKS1 헤더는 일반적으로 LUKS2 헤더보다 작기 때문에 끝에 있는

rbd 크기 조정명령은 불필요한 공간 허용을 제거하기 위해 복제된 이미지를 축소합니다.LUKS-1 형식의 이미지를 사용하여 다음과 같은 효과적인 크기로 LUKS2 형식의 복제를 생성합니다.

구문

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow LUKS2 헤더는 일반적으로 LUKS1 헤더보다 크기 때문에 초기의

rbd 크기명령은 상위 이미지를 일시적으로 확장하여 상위 스냅샷에 일부 추가 공간을 예약하고 복제된 이미지입니다. 이는 복제된 이미지에서 모든 상위 데이터에 액세스할 수 있도록 하려면 필요합니다. 끝에있는 rbd크기 명령은 상위 이미지를 원래 크기로 다시 축소하고 상위 스냅샷과 복제된 이미지에 영향을 주지 않으므로 사용하지 않은 예약된 공간을 제거합니다.포맷되지 않은 이미지에는 헤더가 없기 때문에 포맷되지 않은 이미지의 형식화된 복제를 생성하는 경우에도 마찬가지입니다.

5장. 스냅샷 관리

스토리지 관리자는 Ceph의 스냅샷 기능을 잘 알고 있으면 Red Hat Ceph Storage 클러스터에 저장된 이미지의 스냅샷과 복제본을 관리할 수 있습니다.

5.1. 사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

5.2. Ceph 블록 장치 스냅샷

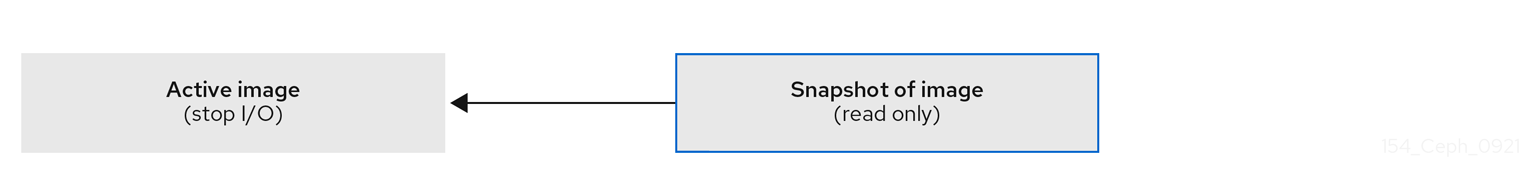

스냅샷은 특정 시점에서의 이미지 상태에 대한 읽기 전용 사본입니다. Ceph 블록 장치의 고급 기능 중 하나는 이미지의 스냅샷을 만들어 이미지 상태 기록을 유지할 수 있다는 것입니다. Ceph는 또한 스냅샷 계층 지정을 지원하므로 이미지를 빠르고 쉽게 복제할 수 있습니다(예: 가상 시스템 이미지). Ceph는 rbd 명령 및 QEMU,libvirt, OpenStack, CloudStack을 비롯한 여러 상위 수준 인터페이스를 사용하는 블록 장치 스냅샷을 지원합니다.

I/O 가 실행되는 동안 스냅샷을 생성하는 경우 스냅샷이 이미지의 정확한 또는 최신 데이터를 가져오지 못할 수 있으며, 마운트할 수 있도록 새 이미지로 스냅샷을 복제해야 할 수 있습니다. Red Hat은 이미지의 스냅샷을 생성하기 전에 I/O 를 중지할 것을 권장합니다. 이미지에 파일 시스템이 포함된 경우 스냅샷을 생성하기 전에 파일 시스템이 일관되게 유지되어야 합니다. I/O 를 중지하려면 fsfreeze 명령을 사용할 수 있습니다. 가상 시스템의 경우 qemu-guest-agent 를 사용하여 스냅샷을 만들 때 파일 시스템을 자동으로 중지할 수 있습니다.

그림 5.1. Ceph 블록 장치 스냅샷

추가 리소스

-

자세한 내용은

fsfreeze(8)도움말 페이지를 참조하십시오.

5.3. Ceph 사용자 및 인증 키

cephx 가 활성화되면 사용자 이름 또는 ID와 사용자의 해당 키가 포함된 인증 키의 경로를 지정해야 합니다.

cephx 는 기본적으로 활성화되어 있습니다.

다음 매개변수가 다시 입력되지 않도록 CEPH_ARGS 환경 변수를 추가할 수도 있습니다.

구문

rbd --id USER_ID --keyring=/path/to/secret [commands] rbd --name USERNAME --keyring=/path/to/secret [commands]

rbd --id USER_ID --keyring=/path/to/secret [commands]

rbd --name USERNAME --keyring=/path/to/secret [commands]예제

rbd --id admin --keyring=/etc/ceph/ceph.keyring [commands] rbd --name client.admin --keyring=/etc/ceph/ceph.keyring [commands]

[root@rbd-client ~]# rbd --id admin --keyring=/etc/ceph/ceph.keyring [commands]

[root@rbd-client ~]# rbd --name client.admin --keyring=/etc/ceph/ceph.keyring [commands]

매번 입력할 필요가 없도록 사용자 및 시크릿을 CEPH_ARGS 환경 변수에 추가합니다.

5.4. 블록 장치 스냅샷 생성

Ceph 블록 장치의 스냅샷을 만듭니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

snap create옵션, 풀 이름 및 이미지 이름을 지정합니다.방법 1:

구문

rbd --pool POOL_NAME snap create --snap SNAP_NAME IMAGE_NAME

rbd --pool POOL_NAME snap create --snap SNAP_NAME IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd --pool pool1 snap create --snap snap1 image1

[root@rbd-client ~]# rbd --pool pool1 snap create --snap snap1 image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 방법 2:

구문

rbd snap create POOL_NAME/IMAGE_NAME@SNAP_NAME

rbd snap create POOL_NAME/IMAGE_NAME@SNAP_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd snap create pool1/image1@snap1

[root@rbd-client ~]# rbd snap create pool1/image1@snap1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.5. 블록 장치 스냅샷 나열

블록 장치 스냅샷을 나열합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

풀 이름과 이미지 이름을 지정합니다.

구문

rbd --pool POOL_NAME --image IMAGE_NAME snap ls rbd snap ls POOL_NAME/IMAGE_NAME

rbd --pool POOL_NAME --image IMAGE_NAME snap ls rbd snap ls POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd --pool pool1 --image image1 snap ls rbd snap ls pool1/image1

[root@rbd-client ~]# rbd --pool pool1 --image image1 snap ls [root@rbd-client ~]# rbd snap ls pool1/image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.6. 블록 장치 스냅샷 롤백

블록 장치 스냅샷을 롤백합니다.

이미지를 스냅샷으로 롤백하면 현재 버전의 이미지를 스냅샷의 데이터로 덮어씁니다. 롤백을 실행하는 데 걸리는 시간은 이미지 크기와 함께 증가합니다. 스냅샷을 스냅샷으로 롤백하는 것보다 스냅샷에서 복제하는 것이 더 빠르며 기존 상태로 돌아가는 것이 좋습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

snap rollback옵션, 풀 이름, 이미지 이름 및 snap 이름을 지정합니다.구문

rbd --pool POOL_NAME snap rollback --snap SNAP_NAME IMAGE_NAME rbd snap rollback POOL_NAME/IMAGE_NAME@SNAP_NAME

rbd --pool POOL_NAME snap rollback --snap SNAP_NAME IMAGE_NAME rbd snap rollback POOL_NAME/IMAGE_NAME@SNAP_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd --pool pool1 snap rollback --snap snap1 image1 rbd snap rollback pool1/image1@snap1

[root@rbd-client ~]# rbd --pool pool1 snap rollback --snap snap1 image1 [root@rbd-client ~]# rbd snap rollback pool1/image1@snap1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.7. 블록 장치 스냅샷 삭제

Ceph 블록 장치의 스냅샷을 삭제합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

블록 장치 스냅샷을 삭제하려면

snap rm옵션, 풀 이름, 이미지 이름 및 스냅샷 이름을 지정합니다.구문

rbd --pool POOL_NAME snap rm --snap SNAP_NAME IMAGE_NAME rbd snap rm POOL_NAME-/IMAGE_NAME@SNAP_NAME

rbd --pool POOL_NAME snap rm --snap SNAP_NAME IMAGE_NAME rbd snap rm POOL_NAME-/IMAGE_NAME@SNAP_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd --pool pool1 snap rm --snap snap2 image1 rbd snap rm pool1/image1@snap1

[root@rbd-client ~]# rbd --pool pool1 snap rm --snap snap2 image1 [root@rbd-client ~]# rbd snap rm pool1/image1@snap1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

이미지에 복제본이 있는 경우 복제된 이미지는 상위 이미지 스냅샷에 대한 참조를 유지합니다. 상위 이미지 스냅샷을 삭제하려면 하위 이미지를 먼저 병합해야 합니다.

Ceph OSD 데몬은 데이터를 비동기적으로 삭제하므로 스냅샷을 삭제해도 디스크 공간이 즉시 확보되지 않습니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 블록 장치 가이드에서 복제된 이미지 플랫화를 참조하십시오.

5.8. 블록 장치 스냅샷 삭제

블록 장치 스냅샷 제거.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

특정 풀에

snap purge옵션 및 이미지 이름을 지정합니다.구문

rbd --pool POOL_NAME snap purge IMAGE_NAME rbd snap purge POOL_NAME/IMAGE_NAME

rbd --pool POOL_NAME snap purge IMAGE_NAME rbd snap purge POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd --pool pool1 snap purge image1 rbd snap purge pool1/image1

[root@rbd-client ~]# rbd --pool pool1 snap purge image1 [root@rbd-client ~]# rbd snap purge pool1/image1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.9. 블록 장치 스냅샷 이름 변경

블록 장치 스냅샷의 이름을 바꿉니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

스냅샷 이름을 변경하려면 다음을 수행합니다.

구문

rbd snap rename POOL_NAME/IMAGE_NAME@ORIGINAL_SNAPSHOT_NAME POOL_NAME/IMAGE_NAME@NEW_SNAPSHOT_NAME

rbd snap rename POOL_NAME/IMAGE_NAME@ORIGINAL_SNAPSHOT_NAME POOL_NAME/IMAGE_NAME@NEW_SNAPSHOT_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd snap rename data/dataset@snap1 data/dataset@snap2

[root@rbd-client ~]# rbd snap rename data/dataset@snap1 data/dataset@snap2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 그러면

data풀의dataset이미지의snap1스냅샷 이름을snap2로 변경합니다.-

rbd help snap rename명령을 실행하여 스냅샷 이름 변경에 대한 추가 세부 정보를 표시합니다.

5.10. Ceph 블록 장치 계층 지정

Ceph에서는 블록 장치 스냅샷의 다양한 COW(Copy-On-Write) 또는 COW(Copy-On-read) 복제본을 만들 수 있습니다. 스냅샷 계층화를 사용하면 Ceph 블록 장치 클라이언트가 이미지를 매우 빠르게 만들 수 있습니다. 예를 들어 Linux VM이 작성된 블록 장치 이미지를 생성할 수 있습니다. 그런 다음 이미지 스냅숏을 만들고 스냅샷을 보호하고 원하는 만큼 복제본을 만듭니다. 스냅샷은 읽기 전용이므로 스냅샷을 복제하면 의미 체계가 간소화됩니다.신속하게 복제본을 만들 수 있도록 합니다.

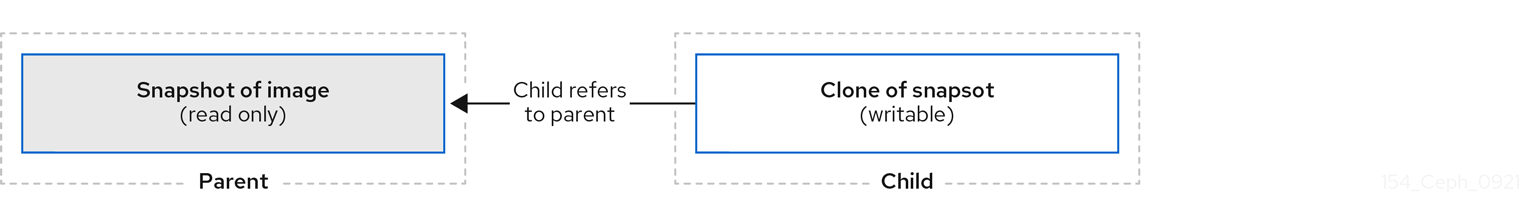

그림 5.2. Ceph 블록 장치 계층 지정

parent 및 child 용어는 Ceph 블록 장치 스냅샷, 상위 및 스냅샷에서 복제된 해당 이미지를 child를 의미합니다. 이러한 용어는 아래의 명령행 사용에 중요합니다.

복제된 각 이미지 하위는 상위 이미지에 참조를 저장하므로 복제된 이미지를 사용하여 상위 스냅샷을 열고 읽을 수 있습니다. 이 참조는 스냅샷의 정보가 복제본에 완전히 복사될 때 복제본이 병합 될 때 제거됩니다.

스냅샷 복제본은 다른 Ceph 블록 장치 이미지와 정확히 동일하게 작동합니다. 복제된 이미지의 읽기, 쓰기, 복제, 크기를 조정할 수 있습니다. 복제된 이미지는 특별한 제한 사항이 없습니다. 그러나 스냅샷 복제본은 스냅샷을 참조하므로 스냅샷을 복제하기 전에 보호해야 합니다.

스냅샷 복제본은 COW(Copy-On-Write) 또는 COW(Copy-On-read) 복제본이 될 수 있습니다. 복제본에는 COW(Copy-On-Write)가 항상 활성화되어 있으며 COW(Copy-on-read)는 명시적으로 활성화해야 합니다. COW(Copy-On-Write)는 복제본 내의 할당되지 않은 오브젝트에 쓰기 시 상위에서 복제본으로 데이터를 복사합니다. COOR(Copy-on-read)은 복제본 내에서 할당되지 않은 개체에서 읽을 때 상위에서 복제본으로 데이터를 복사합니다. 복제본에서 데이터를 읽는 작업은 오브젝트가 복제본에 아직 없는 경우에만 상위 데이터만 읽습니다. RADOS 블록 장치는 대규모 이미지를 여러 오브젝트로 나눕니다. 기본값은 4MB로 설정되고 모든 COW(Copy-On-Write) 및 COW(Copy-on-read) 작업이 전체 개체에서 발생합니다. 이 작업은 복제본에 1바이트를 기록하면 4MB의 개체를 상위로부터 읽고, 대상 개체가 이전 COW/COR 작업에서 복제에 아직 존재하지 않는 경우 복제본에 기록됩니다.

COW(Copy-on-read) 활성화 여부에 관계없이 복제본에서 기본 오브젝트를 읽고 충족할 수 없는 읽기 항목은 상위로 다시 라우팅됩니다. 상위 개수에는 거의 제한이 없기 때문에 복제본을 복제할 수 있다는 의미이므로 이 재경로는 개체가 발견되거나 기본 상위 이미지에 도달할 때까지 계속됩니다. COW(Copy-On-read)가 활성화되면 복제본에서 직접 만족하지 못하는 읽기 결과 전체 개체가 상위에서 읽고 데이터를 복제본에 쓰고 데이터를 복제본에 쓰면 부모로부터 읽을 필요 없이 복제 자체에서 동일한 범위를 읽을 수 있습니다.

이는 기본적으로 온디맨드 개체별 플랫화된 작업입니다. 이 기능은 특히 다른 지리적 위치에서 다른 풀의 부모인 복제본이 대기 시간이 긴 상위 연결에 있을 때 유용합니다. COW(Copy-On-read)를 사용하면 읽기의 분할 대기 시간이 줄어듭니다. 처음 읽기에는 대기 시간이 길지만, 예를 들어 복제본에서 추가 데이터를 읽습니다. 예를 들어 복제본에서 1바이트를 읽지만, 이제 상위 항목에서 4MB를 읽고 복제본에 기록해야 하지만 모든 향후 읽기 항목은 복제본 자체에서 제공됩니다.

스냅샷에서 COW(Copy-on-read) 복제본을 생성하려면 ceph.conf 파일에 rbd_clone_copy_on_read = true 를 추가하여 이 기능을 명시적으로 활성화해야 합니다.

추가 리소스

-

플랫화에 대한 자세한 내용은 Red Hat Ceph Storage Block Device Gudie 의 복제된 이미지

플랫화를참조하십시오.

5.11. 블록 장치 스냅샷 보호

복제본은 상위 스냅샷에 액세스합니다. 사용자가 실수로 상위 스냅샷을 삭제하면 모든 복제본이 손상됩니다.

set-require-min-compat-client 매개변수를 Ceph의 mimic 버전보다 크거나 같음으로 설정할 수 있습니다.

예제

ceph osd set-require-min-compat-client mimic

ceph osd set-require-min-compat-client mimic이렇게 하면 기본적으로 복제본 v2가 생성됩니다. 그러나 mimic보다 오래된 클라이언트는 해당 블록 장치 이미지에 액세스할 수 없습니다.

복제본 v2에는 스냅샷을 보호할 필요가 없습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

다음

명령에서 POOL_NAME,IMAGE_NAME및SNAP_SHOT_NAME을 지정합니다.구문

rbd --pool POOL_NAME snap protect --image IMAGE_NAME --snap SNAPSHOT_NAME rbd snap protect POOL_NAME/IMAGE_NAME@SNAPSHOT_NAME

rbd --pool POOL_NAME snap protect --image IMAGE_NAME --snap SNAPSHOT_NAME rbd snap protect POOL_NAME/IMAGE_NAME@SNAPSHOT_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd --pool pool1 snap protect --image image1 --snap snap1 rbd snap protect pool1/image1@snap1

[root@rbd-client ~]# rbd --pool pool1 snap protect --image image1 --snap snap1 [root@rbd-client ~]# rbd snap protect pool1/image1@snap1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고보호된 스냅샷을 삭제할 수 없습니다.

5.12. 블록 장치 스냅샷 복제

블록 장치 스냅샷을 복제하여 동일한 풀 또는 다른 풀 내에 스냅샷의 하위 이미지를 생성하거나 씁니다. 한 가지 사용 사례는 한 풀에서 읽기 전용 이미지와 스냅샷을 템플릿으로 유지하고 다른 풀에서 쓰기 가능한 복제본을 유지 관리하는 것입니다.

복제본 v2에는 스냅샷을 보호할 필요가 없습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

스냅샷을 복제하려면 상위 풀, 스냅샷, 하위 풀 및 이미지 이름을 지정해야 합니다.

구문

rbd snap --pool POOL_NAME --image PARENT_IMAGE --snap SNAP_NAME --dest-pool POOL_NAME --dest CHILD_IMAGE_NAME rbd clone POOL_NAME/PARENT_IMAGE@SNAP_NAME POOL_NAME/CHILD_IMAGE_NAME

rbd snap --pool POOL_NAME --image PARENT_IMAGE --snap SNAP_NAME --dest-pool POOL_NAME --dest CHILD_IMAGE_NAME rbd clone POOL_NAME/PARENT_IMAGE@SNAP_NAME POOL_NAME/CHILD_IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd clone --pool pool1 --image image1 --snap snap2 --dest-pool pool2 --dest childimage1 rbd clone pool1/image1@snap1 pool1/childimage1

[root@rbd-client ~]# rbd clone --pool pool1 --image image1 --snap snap2 --dest-pool pool2 --dest childimage1 [root@rbd-client ~]# rbd clone pool1/image1@snap1 pool1/childimage1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.13. 블록 장치 스냅샷 보호 해제

스냅샷을 삭제하려면 먼저 보호를 해제해야 합니다. 또한 복제본에서 참조가 있는 스냅샷을 삭제할 수 없습니다. 스냅샷을 삭제하려면 먼저 각 스냅샷 복제본을 병합해야 합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

다음 명령을 실행합니다.

구문

rbd --pool POOL_NAME snap unprotect --image IMAGE_NAME --snap SNAPSHOT_NAME rbd snap unprotect POOL_NAME/IMAGE_NAME@SNAPSHOT_NAME

rbd --pool POOL_NAME snap unprotect --image IMAGE_NAME --snap SNAPSHOT_NAME rbd snap unprotect POOL_NAME/IMAGE_NAME@SNAPSHOT_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd --pool pool1 snap unprotect --image image1 --snap snap1 rbd snap unprotect pool1/image1@snap1

[root@rbd-client ~]# rbd --pool pool1 snap unprotect --image image1 --snap snap1 [root@rbd-client ~]# rbd snap unprotect pool1/image1@snap1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.14. 스냅샷의 하위 항목 나열

스냅샷의 하위 항목을 나열합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

스냅샷의 하위 항목을 나열하려면 다음을 실행합니다.

구문

rbd --pool POOL_NAME children --image IMAGE_NAME --snap SNAP_NAME rbd children POOL_NAME/IMAGE_NAME@SNAPSHOT_NAME

rbd --pool POOL_NAME children --image IMAGE_NAME --snap SNAP_NAME rbd children POOL_NAME/IMAGE_NAME@SNAPSHOT_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd --pool pool1 children --image image1 --snap snap1 rbd children pool1/image1@snap1

[root@rbd-client ~]# rbd --pool pool1 children --image image1 --snap snap1 [root@rbd-client ~]# rbd children pool1/image1@snap1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.15. 복제된 이미지 병합

복제된 이미지에는 상위 스냅샷에 대한 참조가 유지됩니다. 하위 복제본에서 상위 스냅샷에 대한 참조를 제거하면 스냅샷의 정보를 복제본에 복사하여 이미지를 실제로 "플랫"합니다. 복제본을 병합하는 데 걸리는 시간은 스냅샷 크기와 함께 증가합니다. 병합된 이미지에는 스냅샷의 모든 정보가 포함되어 있기 때문에 병합된 이미지에서 계층 복제보다 더 많은 스토리지 공간을 사용합니다.

이미지에서 심층 플랫 기능이 활성화된 경우 이미지 복제본은 기본적으로 상위 항목과 분리됩니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

하위 이미지와 연결된 상위 이미지 스냅샷을 삭제하려면 하위 이미지를 먼저 병합해야 합니다.

구문

rbd --pool POOL_NAME flatten --image IMAGE_NAME rbd flatten POOL_NAME/IMAGE_NAME

rbd --pool POOL_NAME flatten --image IMAGE_NAME rbd flatten POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

rbd --pool pool1 flatten --image childimage1 rbd flatten pool1/childimage1

[root@rbd-client ~]# rbd --pool pool1 flatten --image childimage1 [root@rbd-client ~]# rbd flatten pool1/childimage1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6장. Ceph 블록 장치 미러링

스토리지 관리자는 Red Hat Ceph Storage 클러스터 간에 데이터 이미지를 미러링하여 Ceph 블록 장치에 다른 중복 계층을 추가할 수 있습니다. Ceph 블록 장치 미러링을 이해하고 사용하면 사이트 장애와 같은 데이터 손실을 방지할 수 있습니다. Ceph 블록 장치를 미러링하는 데는 일방향 미러링 또는 양방향 미러링의 두 가지 구성이 있으며 풀과 개별 이미지에 미러링을 구성할 수 있습니다.

6.1. 사전 요구 사항

- Red Hat Ceph Storage 클러스터를 실행하는 최소 두 개의 정상 실행.

- 두 스토리지 클러스터 간의 네트워크 연결.

- 각 Red Hat Ceph Storage 클러스터의 Ceph 클라이언트 노드에 액세스합니다.

- 관리자 수준의 기능이 있는 CephX 사용자.

6.2. Ceph 블록 장치 미러링

RADOS 블록 장치(RBD) 미러링은 두 개 이상의 Ceph 스토리지 클러스터 간에 Ceph 블록 장치 이미지의 비동기 복제 프로세스입니다. 다른 지리적 위치에 Ceph 스토리지 클러스터를 배치하면 RBD Mirroring을 통해 사이트 재해에서 복구할 수 있습니다. 저널 기반 Ceph 블록 장치 미러링은 읽기 및 쓰기, 블록 장치 크기 조정, 스냅샷, 복제본 및 플랫화를 포함하여 모든 이미지에 대해 지점에서 일관된 복제를 보장합니다.

RBD 미러링은 배타적 잠금 및 저널링 기능을 사용하여 이미지에 대한 모든 수정 사항을 발생하는 순서대로 기록합니다. 따라서 이미지의 크래시 일관성 미러를 사용할 수 있습니다.

블록 장치 이미지를 미러링하는 기본 및 보조 풀을 지원하는 CRUSH 계층 구조에는 동일한 용량 및 성능 특성이 있어야 하며 초과 대기 시간 없이 미러링할 수 있는 적절한 대역폭이 있어야 합니다. 예를 들어 기본 스토리지 클러스터의 이미지에 대한 X MB/s 평균 쓰기 처리량이 있는 경우 네트워크에서 보조 사이트에 네트워크 연결에서 N * X 처리량을 지원하고 안전 계수 Y%를 사용하여 N 이미지를 미러링해야 합니다.

rbd-mirror 데몬은 원격 기본 이미지의 변경 사항을 가져와서 특정 Ceph 스토리지 클러스터에서 다른 Ceph 스토리지 클러스터로 이미지를 동기화하고 이러한 변경 사항을 로컬 비기본 이미지로 기록합니다. rbd-mirror 데몬은 단방향 미러링을 위해 단일 Ceph 스토리지 클러스터에서 실행하거나 미러링 관계에 참여하는 양방향 미러링을 위해 두 개의 Ceph 스토리지 클러스터에서 실행할 수 있습니다.

RBD 미러링이 작동하려면 단방향 또는 양방향 복제를 사용하는 경우 몇 가지 가정이 이루어집니다.

- 두 스토리지 클러스터에 모두 이름이 같은 풀이 있습니다.

- 풀에는 미러링하려는 저널 지원 이미지가 포함되어 있습니다.

단방향 또는 양방향 복제에서는 rbd-mirror 의 각 인스턴스를 동시에 다른 Ceph 스토리지 클러스터에 연결할 수 있어야 합니다. 또한 네트워크에는 미러링을 처리하기 위해 두 데이터 센터 사이트 간에 충분한 대역폭이 있어야 합니다.

일방향 복제

단방향 미러링은 한 스토리지 클러스터에 있는 기본 이미지 또는 이미지 풀이 보조 스토리지 클러스터에 복제됨을 의미합니다. 단방향 미러링은 여러 보조 스토리지 클러스터에 대한 복제도 지원합니다.

보조 스토리지 클러스터에서 이미지는 기본이 아닌 복제입니다. 즉, Ceph 클라이언트가 이미지에 쓸 수 없습니다. 데이터가 기본 스토리지 클러스터에서 보조 스토리지 클러스터로 미러링되면 rbd-mirror 는 보조 스토리지 클러스터에서만 실행됩니다.

단방향 미러링이 작동하려면 몇 가지 가정이 이루어집니다.

- Ceph 스토리지 클러스터가 두 개 있으며 기본 스토리지 클러스터에서 보조 스토리지 클러스터로 이미지를 복제해야 합니다.

-

보조 스토리지 클러스터에는

rbd-mirror데몬을 실행하는 Ceph 클라이언트 노드가 연결되어 있습니다.rbd-mirror데몬은 기본 스토리지 클러스터에 연결하여 이미지를 보조 스토리지 클러스터에 동기화합니다.

그림 6.1. 단방향 미러링

양방향 복제

양방향 복제는 기본 클러스터에 rbd-mirror 데몬을 추가하여 이미지를 강등하고 보조 클러스터에서 승격할 수 있도록 합니다. 그런 다음 보조 클러스터의 이미지를 변경할 수 있으며 2차에서 1차로 역방향으로 복제됩니다. 클러스터에서 이미지를 승격하고 강등할 수 있도록 두 클러스터 모두 rbd-mirror 를 실행해야 합니다. 현재는 양방향 복제는 두 사이트 사이에서만 지원됩니다.

양방향 미러링이 작동하려면 몇 가지 가정이 이루어집니다.

- 두 개의 스토리지 클러스터가 있으며 두 방향으로 이미지를 복제할 수 있습니다.

-

두 스토리지 클러스터에 모두

rbd-mirror데몬을 실행하는 클라이언트 노드가 연결되어 있습니다. 보조 스토리지 클러스터에서 실행되는rbd-mirror데몬은 기본 스토리지 클러스터에 연결하여 이미지를 보조 스토리지에 동기화하고, 기본 스토리지 클러스터에서 실행되는rbd-mirror데몬은 보조 스토리지 클러스터에 연결하여 이미지를 기본 스토리지 클러스터에 동기화합니다.

그림 6.2. 양방향 미러링

미러링 모드

미러링은 미러 피어링 스토리지 클러스터와 함께 풀 단위로 구성됩니다. Ceph는 풀의 이미지 유형에 따라 두 가지 미러링 모드를 지원합니다.

- 풀 모드

- 저널링 기능이 활성화된 풀의 모든 이미지가 미러링됩니다.

- 이미지 모드

- 풀 내의 특정 이미지 하위 집합만 미러링됩니다. 각 이미지에 대해 별도로 미러링을 활성화해야 합니다.

이미지 상태

이미지를 수정할 수 있는지 여부는 상태에 따라 다릅니다.

- 기본 상태의 이미지를 수정할 수 있습니다.

- 기본이 아닌 상태의 이미지는 수정할 수 없습니다.

이미지에서 미러링을 처음 활성화하면 이미지가 자동으로 기본으로 승격됩니다. 프로모션이 발생할 수 있습니다.

- 풀 모드에서 미러링을 활성화하여 암시적으로.

- 특정 이미지의 미러링을 활성화하여 명시적으로 표시합니다.

기본 이미지를 강등하고 기본이 아닌 이미지를 승격할 수 있습니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Block Device Guide 의 이미지 승격 및 강등 섹션을 참조하십시오.

6.2.1. 저널 기반 및 스냅샷 기반 미러링 개요

RBD 이미지는 두 가지 모드를 통해 두 개의 Red Hat Ceph Storage 클러스터 간에 비동기식으로 미러링할 수 있습니다.

FlexVolume 기반 미러링

이 모드에서는 RBD 저널링 이미지 기능을 사용하여 두 개의 Red Hat Ceph Storage 클러스터 간에 지점 간 일관된 복제를 보장합니다. RBD 이미지에 대한 모든 쓰기가 관련 저널에 먼저 기록되는 경우 실제 이미지는 수정되지 않습니다. 원격 클러스터는 이 저널에서 읽고 업데이트를 이미지의 로컬 복사본에 재생합니다. RBD 이미지를 쓸 때마다 Ceph 클러스터에 두 개의 쓰기 작업이 생성되므로 쓰기 대기 시간이 RBD 저널링 이미지 기능을 사용하여 거의 두 배가 됩니다.

스냅샷 기반 미러링

이 모드는 정기적으로 예약되거나 수동으로 생성된 RBD 이미지 미러 스냅샷을 사용하여 두 개의 Red Hat Ceph Storage 클러스터 간에 충돌하는 일관된 RBD 이미지를 복제합니다. 원격 클러스터는 두 개의 미러 스냅샷 간 데이터 또는 메타데이터 업데이트를 확인하고 deltas를 이미지의 로컬 사본에 복사합니다. RBD fast-diff 이미지 기능을 사용하면 전체 RBD 이미지를 스캔하지 않고도 업데이트된 데이터 블록을 신속하게 확인할 수 있습니다. 장애 조치(failover) 시나리오에서 사용하기 전에 두 스냅샷 간의 전체 delta를 동기화해야 합니다. 부분적으로 적용된 모든 delta 세트는 페일오버 시 롤백됩니다.

6.3. 명령줄 인터페이스를 사용하여 일방향 미러링 구성

이 절차에서는 기본 스토리지 클러스터에서 보조 스토리지 클러스터로 풀의 일방향 복제를 구성합니다.

단방향 복제를 사용하는 경우 여러 보조 스토리지 클러스터에 미러링할 수 있습니다.

이 섹션의 예제에서는 기본 이미지를 site-a로 사용하여 기본 스토리지 클러스터를 참조하여 두 개의 스토리지 클러스터를 구분하고 이미지를 로 복제하는 보조 스토리지 클러스터를 구분합니다. 이러한 예제에서 사용된 풀 이름을 site- bdata 라고 합니다.

사전 요구 사항

- 최소 2개의 정상 및 실행 중인 Red Hat Ceph Storage 클러스터.

- 각 스토리지 클러스터의 Ceph 클라이언트 노드에 대한 루트 수준 액세스.

- 관리자 수준의 기능이 있는 CephX 사용자.

절차

두 사이트 모두에서

cephadm쉘에 로그인합니다.예제

cephadm shell cephadm shell

[root@site-a ~]# cephadm shell [root@site-b ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-b에서 보조 클러스터에서 mirror 데몬 배포를 예약합니다.구문

ceph orch apply rbd-mirror --placement=NODENAME

ceph orch apply rbd-mirror --placement=NODENAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@site-b /]# ceph orch apply rbd-mirror --placement=host04

[ceph: root@site-b /]# ceph orch apply rbd-mirror --placement=host04Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고nodename은 보조 클러스터에서 미러링을 설정하려는 호스트입니다.site-a의 이미지에서 저널링 기능을 활성화합니다.새 이미지의 경우

--image-feature옵션을 사용하십시오.구문

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME --image-feature FEATURE FEATURE

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME --image-feature FEATURE FEATURECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@site-a /]# rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journaling

[ceph: root@site-a /]# rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journalingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고exclusive-lock이 이미 활성화된 경우journaling을 유일한 인수로 사용하십시오. 그렇지 않으면 다음 오류를 반환합니다.one or more requested features are already enabled (22) Invalid argument

one or more requested features are already enabled (22) Invalid argumentCopy to Clipboard Copied! Toggle word wrap Toggle overflow 기존 이미지의 경우

rbd feature enable명령을 사용합니다.구문

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE, FEATURE

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE, FEATURECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@site-a /]# rbd feature enable data/image1 exclusive-lock, journaling

[ceph: root@site-a /]# rbd feature enable data/image1 exclusive-lock, journalingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 기본적으로 모든 새 이미지에서 저널링을 활성화합니다.

구문

ceph config set global rbd_default_features SUM_OF_FEATURE_NUMERIC_VALUES ceph config show HOST01 rbd_default_features

ceph config set global rbd_default_features SUM_OF_FEATURE_NUMERIC_VALUES ceph config show HOST01 rbd_default_featuresCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@site-a /]# ceph config set global rbd_default_features 125 [ceph: root@site-a /]# ceph config show mon.host01 rbd_default_features

[ceph: root@site-a /]# ceph config set global rbd_default_features 125 [ceph: root@site-a /]# ceph config show mon.host01 rbd_default_featuresCopy to Clipboard Copied! Toggle word wrap Toggle overflow

두 스토리지 클러스터에서 미러링 모드(풀 또는 이미지 모드)를 선택합니다.

풀 모드 활성화 :

구문

rbd mirror pool enable POOL_NAME MODE

rbd mirror pool enable POOL_NAME MODECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@site-a /]# rbd mirror pool enable data pool [ceph: root@site-b /]# rbd mirror pool enable data pool

[ceph: root@site-a /]# rbd mirror pool enable data pool [ceph: root@site-b /]# rbd mirror pool enable data poolCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 예에서는

data라는 전체 풀을 미러링할 수 있습니다.이미지 모드 활성화 :

구문

rbd mirror pool enable POOL_NAME MODE

rbd mirror pool enable POOL_NAME MODECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@site-a /]# rbd mirror pool enable data image [ceph: root@site-b /]# rbd mirror pool enable data image

[ceph: root@site-a /]# rbd mirror pool enable data image [ceph: root@site-b /]# rbd mirror pool enable data imageCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 예에서는

data풀에서 이미지 모드 미러링을 활성화합니다.참고풀의 특정 이미지에 미러링을 사용하려면 Red Hat Ceph Storage 블록 장치 가이드 의 이미지 미러링 활성화 섹션을 참조하십시오.

두 사이트 모두에서 미러링이 성공적으로 활성화되었는지 확인합니다.

구문

rbd mirror pool info POOL_NAME

rbd mirror pool info POOL_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Ceph 클라이언트 노드에서 스토리지 클러스터 피어를 부트스트랩합니다.

Ceph 사용자 계정을 생성하고 스토리지 클러스터 피어를 풀에 등록합니다.

구문

rbd mirror pool peer bootstrap create --site-name PRIMARY_LOCAL_SITE_NAME POOL_NAME > PATH_TO_BOOTSTRAP_TOKEN

rbd mirror pool peer bootstrap create --site-name PRIMARY_LOCAL_SITE_NAME POOL_NAME > PATH_TO_BOOTSTRAP_TOKENCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@rbd-client-site-a /]# rbd mirror pool peer bootstrap create --site-name site-a data > /root/bootstrap_token_site-a

[ceph: root@rbd-client-site-a /]# rbd mirror pool peer bootstrap create --site-name site-a data > /root/bootstrap_token_site-aCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고이 예제 부트스트랩 명령은

client.rbd-mirror.site-a및client.rbd-mirror-peerCeph 사용자를 생성합니다.-

부트스트랩 토큰 파일을

site-b스토리지 클러스터에 복사합니다. site-b스토리지 클러스터에서 부트스트랩 토큰을 가져옵니다.구문

rbd mirror pool peer bootstrap import --site-name SECONDARY_LOCAL_SITE_NAME --direction rx-only POOL_NAME PATH_TO_BOOTSTRAP_TOKEN

rbd mirror pool peer bootstrap import --site-name SECONDARY_LOCAL_SITE_NAME --direction rx-only POOL_NAME PATH_TO_BOOTSTRAP_TOKENCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@rbd-client-site-b /]# rbd mirror pool peer bootstrap import --site-name site-b --direction rx-only data /root/bootstrap_token_site-a

[ceph: root@rbd-client-site-b /]# rbd mirror pool peer bootstrap import --site-name site-b --direction rx-only data /root/bootstrap_token_site-aCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고단방향 RBD 미러링의 경우 부트스트랩 피어를 부트 스트랩할 때 양방향 미러링이 기본값이므로

--direction rx-only인수를 사용해야 합니다.

미러링 상태를 확인하려면 기본 및 보조 사이트의 Ceph 모니터 노드에서 다음 명령을 실행합니다.

구문

rbd mirror image status POOL_NAME/IMAGE_NAME

rbd mirror image status POOL_NAME/IMAGE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 여기서는

rbd-mirror데몬이 실행 중임을 의미하며중지됨은 이 이미지가 다른 스토리지 클러스터에서 복제 대상이 아님을 의미합니다. 이는 이미지가 이 스토리지 클러스터에서 기본이기 때문입니다.예제

[ceph: root@mon-site-b /]# rbd mirror image status data/image1 image1: global_id: c13d8065-b33d-4cb5-b35f-127a02768e7f

[ceph: root@mon-site-b /]# rbd mirror image status data/image1 image1: global_id: c13d8065-b33d-4cb5-b35f-127a02768e7fCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4. 명령줄 인터페이스를 사용하여 양방향 미러링 구성

이 절차에서는 기본 스토리지 클러스터와 보조 스토리지 클러스터 간에 풀의 양방향 복제를 구성합니다.

양방향 복제를 사용하는 경우 두 스토리지 클러스터만 미러링할 수 있습니다.

이 섹션의 예제에서는 기본 이미지를 site-a로 사용하여 기본 스토리지 클러스터를 참조하여 두 개의 스토리지 클러스터를 구분하고 이미지를 로 복제하는 보조 스토리지 클러스터를 구분합니다. 이러한 예제에서 사용된 풀 이름을 site- bdata 라고 합니다.

사전 요구 사항

- 최소 2개의 정상 및 실행 중인 Red Hat Ceph Storage 클러스터.

- 각 스토리지 클러스터의 Ceph 클라이언트 노드에 대한 루트 수준 액세스.

- 관리자 수준의 기능이 있는 CephX 사용자.

절차

두 사이트 모두에서

cephadm쉘에 로그인합니다.예제

cephadm shell cephadm shell

[root@site-a ~]# cephadm shell [root@site-b ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow site-a기본 클러스터에서 다음 명령을 실행합니다.예제

[ceph: root@site-a /]# ceph orch apply rbd-mirror --placement=host01

[ceph: root@site-a /]# ceph orch apply rbd-mirror --placement=host01Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고nodename은 미러링을 설정하려는 호스트입니다.site-b에서 보조 클러스터에서 mirror 데몬 배포를 예약합니다.구문

ceph orch apply rbd-mirror --placement=NODENAME

ceph orch apply rbd-mirror --placement=NODENAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@site-b /]# ceph orch apply rbd-mirror --placement=host04

[ceph: root@site-b /]# ceph orch apply rbd-mirror --placement=host04Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고nodename은 보조 클러스터에서 미러링을 설정하려는 호스트입니다.site-a의 이미지에서 저널링 기능을 활성화합니다.새 이미지의 경우

--image-feature옵션을 사용하십시오.구문

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME --image-feature FEATURE FEATURE

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME --image-feature FEATURE FEATURECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@site-a /]# rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journaling

[ceph: root@site-a /]# rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journalingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고exclusive-lock이 이미 활성화된 경우journaling을 유일한 인수로 사용하십시오. 그렇지 않으면 다음 오류를 반환합니다.one or more requested features are already enabled (22) Invalid argument

one or more requested features are already enabled (22) Invalid argumentCopy to Clipboard Copied! Toggle word wrap Toggle overflow 기존 이미지의 경우

rbd feature enable명령을 사용합니다.구문

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE, FEATURE

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE, FEATURECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@site-a /]# rbd feature enable data/image1 exclusive-lock, journaling

[ceph: root@site-a /]# rbd feature enable data/image1 exclusive-lock, journalingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 기본적으로 모든 새 이미지에서 저널링을 활성화합니다.

구문

ceph config set global rbd_default_features SUM_OF_FEATURE_NUMERIC_VALUES ceph config show HOST01 rbd_default_features

ceph config set global rbd_default_features SUM_OF_FEATURE_NUMERIC_VALUES ceph config show HOST01 rbd_default_featuresCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@site-a /]# ceph config set global rbd_default_features 125 [ceph: root@site-a /]# ceph config show mon.host01 rbd_default_features

[ceph: root@site-a /]# ceph config set global rbd_default_features 125 [ceph: root@site-a /]# ceph config show mon.host01 rbd_default_featuresCopy to Clipboard Copied! Toggle word wrap Toggle overflow

두 스토리지 클러스터에서 미러링 모드(풀 또는 이미지 모드)를 선택합니다.

풀 모드 활성화 :

구문

rbd mirror pool enable POOL_NAME MODE

rbd mirror pool enable POOL_NAME MODECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@site-a /]# rbd mirror pool enable data pool [ceph: root@site-b /]# rbd mirror pool enable data pool