가상화 관리 가이드

가상 환경 관리

초록

1장. 서버 모범 사례

- 강제 모드에서 SELinux를 실행합니다. setenforce 명령을 사용하여 SELinux를 강제 모드로 설정합니다.

setenforce 1

# setenforce 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow - AutoFS, NFS ,NFS,FTP,HTTP,NIS,telnetd 와 같은 불필요한 서비스를 제거하거나 비활성화합니다.

- 서버의 플랫폼 관리에 필요한 최소 사용자 계정 수만 추가하고 불필요한 사용자 계정을 제거합니다.

- 호스트에서 필수 애플리케이션이 실행되지 않도록 합니다. 호스트에서 애플리케이션을 실행하면 가상 시스템 성능에 영향을 줄 수 있으며 서버 안정성에 영향을 미칠 수 있습니다. 서버에 충돌이 발생할 수 있는 모든 애플리케이션도 서버의 모든 가상 시스템을 작동 중단시킵니다.

- 가상 시스템 설치 및 이미지에 중앙 위치를 사용합니다. 가상 머신 이미지는

/var/lib/libvirt/images/에 저장해야 합니다. 가상 머신 이미지에 다른 디렉터리를 사용하는 경우 디렉토리를 SELinux 정책에 추가하고 설치를 시작하기 전에 레이블을 다시 지정해야 합니다. 공유 가능한 공유 가능, 중앙 위치에서 네트워크 스토리지를 사용하는 것이 좋습니다.

2장. sVirt

비가상화 환경

가상화되지 않은 환경에서는 호스트 물리적 시스템이 서로 분리되어 있으며 각 호스트 물리적 시스템에는 웹 서버 또는 DNS 서버와 같은 서비스로 구성된 자체 포함 환경이 있습니다. 이러한 서비스는 자체 사용자 공간과 물리적 시스템의 커널 및 물리적 하드웨어와 직접 통신하여 네트워크에 직접 서비스를 제공합니다. 다음 이미지는 가상화되지 않은 환경을 나타냅니다.

- ??????

- 사용자 공간 - 모든 사용자 모드 애플리케이션과 일부 드라이버가 실행되는 메모리 영역입니다.

- ???

- 웹 앱(웹 애플리케이션 서버) - 브라우저를 통해 액세스할 수 있는 웹 콘텐츠를 제공합니다.

- ??????

- 호스트 커널 - 호스트 물리적 시스템의 권한 있는 커널, 커널 확장 및 대부분의 장치 드라이버를 실행하기 위해 엄격하게 예약되어 있습니다.

- ???

- DNS 서버 - 사용자가 IP 주소 대신 논리 이름을 사용하여 웹 페이지에 액세스할 수 있도록 허용하는 DNS 레코드를 저장합니다.

가상화된 환경

가상화 환경에서 호스트 물리적 시스템에 상주하는 단일 커널에서 여러 가상 운영 체제를 실행할 수 있습니다. 다음 이미지는 가상화된 환경을 나타냅니다.

2.1. 보안 및 가상화

2.2. KnativeServing 라벨링

ps -eZ | grep qemu system_u:system_r:svirt_t:s0:c87,c520 27950 ? 00:00:17 qemu-kvm

# ps -eZ | grep qemu

system_u:system_r:svirt_t:s0:c87,c520 27950 ? 00:00:17 qemu-kvm

ls -lZ /var/lib/libvirt/images/* system_u:object_r:svirt_image_t:s0:c87,c520 image1

# ls -lZ /var/lib/libvirt/images/*

system_u:object_r:svirt_image_t:s0:c87,c520 image1

| SELinux Context | 유형 / 설명 |

|---|---|

| system_u:system_r:svirt_t:MCS1 | 게스트 가상 머신 프로세스. MCS1은 임의의 MCS 필드입니다. 대략 500,000개의 레이블이 지원됩니다. |

| system_u:object_r:svirt_image_t:MCS1 | 게스트 가상 머신 이미지. MCS 필드가 동일한 svirt_t 프로세스만 이러한 이미지를 읽고 쓸 수 있습니다. |

| system_u:object_r:svirt_image_t:s0 | 게스트 가상 머신 공유 읽기/쓰기 콘텐츠. 모든 svirt_t 프로세스는 svirt_image_t:s0 파일에 쓸 수 있습니다. |

3장. 가상 머신 복제

- 복제본은 단일 가상 시스템의 인스턴스입니다. 복제본은 동일한 가상 머신의 네트워크를 설정하는 데 사용할 수 있으며 다른 대상에 배포할 수도 있습니다.

- 템플릿 은 복제용 소스로 사용하도록 설계된 가상 머신의 인스턴스입니다. 템플릿에서 여러 복제본을 생성하고 각 복제를 약간 수정할 수 있습니다. 이는 시스템에서 이러한 변경의 영향을 확인하는 데 유용합니다.

- 플랫폼 수준 정보 및 구성에는 가상화 솔루션에서 가상 머신에 할당한 모든 사항이 포함됩니다. 예를 들면 NIC(네트워크 인터페이스 카드) 및 해당 MAC 주소가 있습니다.

- 게스트 운영 체제 수준 정보 및 구성에는 가상 머신 내에서 구성된 모든 항목이 포함됩니다. 예를 들면 SSH 키가 있습니다.

- 애플리케이션 수준 정보 및 구성에는 가상 머신에 설치된 애플리케이션에서 구성하는 모든 내용이 포함됩니다. 예를 들면 활성화 코드 및 등록 정보가 있습니다.참고이 장에서는 정보 및 접근 방식이 각 애플리케이션에 고유하므로 애플리케이션 수준 제거에 대한 정보는 포함되지 않습니다.

3.1. 클로닝을 위해 가상 머신 준비

절차 3.1. 복제를 위한 가상 머신 준비

가상 머신 설정

- 복제본 또는 템플릿에 사용할 가상 머신을 빌드합니다.

- 복제본에 필요한 소프트웨어를 설치합니다.

- 운영 체제에 대한 고유하지 않은 설정을 구성합니다.

- 고유하지 않은 애플리케이션 설정을 구성합니다.

네트워크 구성 제거

- 다음 명령을 사용하여 영구 udev 규칙을 제거합니다.

rm -f /etc/udev/rules.d/70-persistent-net.rules

# rm -f /etc/udev/rules.d/70-persistent-net.rulesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고udev 규칙이 제거되지 않으면 첫 번째 NIC 이름은 eth0 대신 eth1일 수 있습니다. - ifcfg 스크립트에서

/etc/sysconfig/network-scripts/ifcfg-eth[x]를 다음과 같이 편집하여 고유한 네트워크 세부 정보를 제거합니다.- HWADDR 및 정적 행 제거참고HWADDR이 새 게스트의 MAC 주소와 일치하지 않으면 ifcfg가 무시됩니다. 따라서 파일에서 HWADDR을 제거하는 것이 중요합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - DHCP 구성이 HWADDR 또는 고유한 정보가 포함되지 않은 상태로 남아 있는지 확인합니다.

DEVICE=eth[x] BOOTPROTO=dhcp ONBOOT=yes

DEVICE=eth[x] BOOTPROTO=dhcp ONBOOT=yesCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 파일에 다음 행이 포함되어 있는지 확인합니다.

DEVICE=eth[x] ONBOOT=yes

DEVICE=eth[x] ONBOOT=yesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- 다음 파일이 있는 경우 해당 파일에 동일한 콘텐츠가 포함되어 있는지 확인합니다.

/etc/sysconfig/networking/devices/ifcfg-eth[x]/etc/sysconfig/networking/profiles/default/ifcfg-eth[x]

참고NetworkManager 또는 특수 설정을 가상 시스템과 함께 사용한 경우 추가 고유 정보가 ifcfg 스크립트에서 제거되었는지 확인합니다.

등록 세부 정보 제거

- 다음 중 하나를 사용하여 등록 세부 정보를 제거합니다.

- RHN(Red Hat Network)에 등록된 게스트 가상 머신의 경우 다음 명령을 실행합니다.

rm /etc/sysconfig/rhn/systemid

# rm /etc/sysconfig/rhn/systemidCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Subscription Manager (RHSM)가 등록된 게스트 가상 머신의 경우:

- 원래 가상 머신을 사용하지 않는 경우 다음 명령을 실행합니다.

subscription-manager unsubscribe --all subscription-manager unregister subscription-manager clean

# subscription-manager unsubscribe --all # subscription-manager unregister # subscription-manager cleanCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 원래 가상 시스템을 사용하는 경우 다음 명령만 실행합니다.

subscription-manager clean

# subscription-manager cleanCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고원래 RHSM 프로파일은 포털에 남아 있습니다.

기타 고유한 세부 정보 제거

- 다음 명령을 사용하여 sshd 공개/개인 키 쌍을 제거합니다.

rm -rf /etc/ssh/ssh_host_*

# rm -rf /etc/ssh/ssh_host_*Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고ssh 키를 제거하면 ssh 클라이언트의 문제가 이러한 호스트를 신뢰하지 않습니다. - 여러 시스템에서 실행되는 경우 충돌을 일으킬 수 있는 다른 애플리케이션별 식별자 또는 구성을 제거합니다.

다음 부팅 시 구성 마법사를 실행하도록 가상 머신 구성

- 다음 중 하나를 수행하여 부팅될 때 관련 구성 마법사를 실행하도록 가상 머신을 구성합니다.

- Red Hat Enterprise Linux 6 이하의 경우 다음 명령을 사용하여 .unconfigured라는 루트 파일 시스템에 빈 파일을 생성합니다.

touch /.unconfigured

# touch /.unconfiguredCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Enterprise Linux 7의 경우 다음 명령을 실행하여 첫 번째 부팅 및 초기 설정 마법사를 활성화하십시오.

sed -ie 's/RUN_FIRSTBOOT=NO/RUN_FIRSTBOOT=YES/' /etc/sysconfig/firstboot systemctl enable firstboot-graphical systemctl enable initial-setup-graphical

# sed -ie 's/RUN_FIRSTBOOT=NO/RUN_FIRSTBOOT=YES/' /etc/sysconfig/firstboot # systemctl enable firstboot-graphical # systemctl enable initial-setup-graphicalCopy to Clipboard Copied! Toggle word wrap Toggle overflow

참고다음 부팅 시 실행되는 마법사는 가상 머신에서 제거된 구성에 따라 다릅니다. 또한 복제본의 첫 번째 부팅 시 호스트 이름을 변경하는 것이 좋습니다.

3.2. 가상 머신 복제

3.2.1. virt-clone을 사용하여 게스트 복제

--original 만 필요합니다. 전체 옵션 목록을 보려면 다음 명령을 입력합니다.

virt-clone --help

# virt-clone --help예 3.1. virt-clone 을 사용하여 게스트 복제

virt-clone --original demo --auto-clone

# virt-clone --original demo --auto-clone예 3.2. virt-clone 을 사용하여 게스트 복제

virt-clone --connect qemu:///system --original demo --name newdemo --file /var/lib/xen/images/newdemo.img --file /var/lib/xen/images/newdata.img

# virt-clone --connect qemu:///system --original demo --name newdemo --file /var/lib/xen/images/newdemo.img --file /var/lib/xen/images/newdata.img3.2.2. virt-manager를 사용하여 게스트 복제

절차 3.2. virt-manager를 사용하여 가상 머신 복제

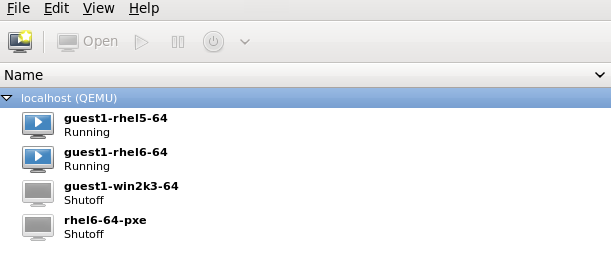

virt-manager를 엽니다.

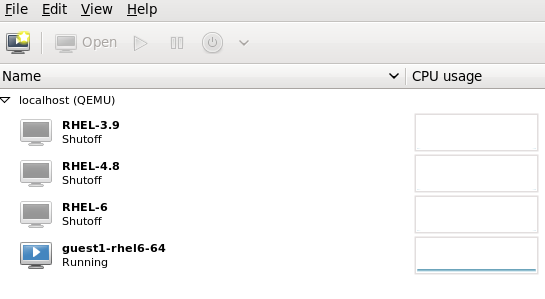

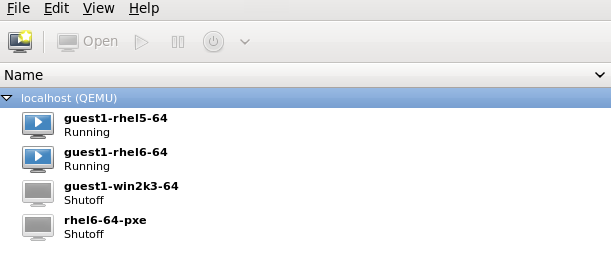

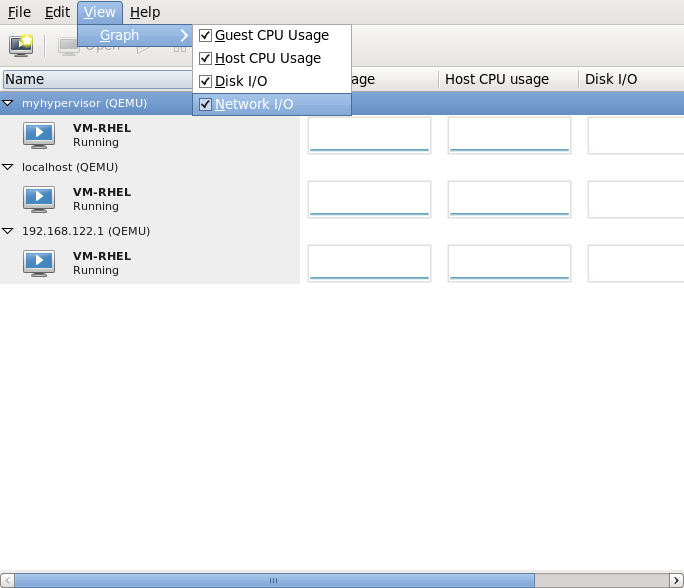

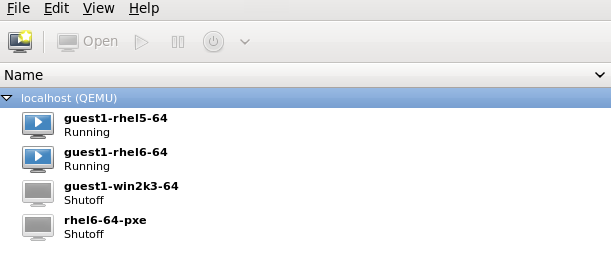

virt-manager 를 시작합니다. (애플리케이션) 메뉴 및 (시스템 도구) 하위 메뉴에서 애플리케이션을 시작합니다. 또는 root로 virt-manager 명령을 실행합니다.가상 머신 관리자 의 게스트 가상 머신 목록에서 복제할 게스트 가상 머신을 선택합니다.복제할 guest 가상 머신을 마우스 오른쪽 버튼으로 클릭하고 을 선택합니다. Clone Virtual Machine(가상 시스템 복제) 창이 열립니다.그림 3.1. 가상 머신 창 복제

복제 구성

- 복제본 이름을 변경하려면 복제본에 새 이름을 입력합니다.

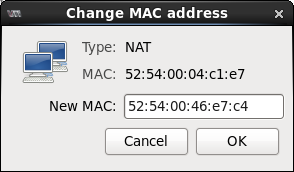

- 네트워킹 구성을 변경하려면 세부 정보를 클릭합니다.복제본에 새 MAC 주소를 입력합니다.OK를 클릭합니다.

그림 3.2. MAC 주소 창 변경

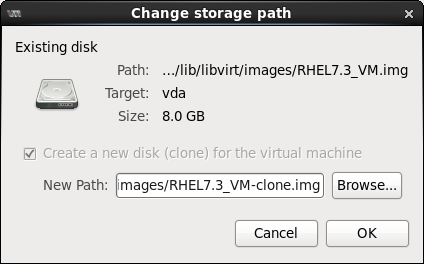

- 복제된 게스트 가상 머신의 각 디스크에 대해 다음 옵션 중 하나를 선택합니다.

이 디스크 복제- 복제된 게스트 가상 머신에 대해 디스크가 복제됩니다.디스크를 게스트 가상 머신 이름과공유 - 복제된 게스트 가상 머신에서 디스크를 공유합니다.세부 정보- 디스크의 새 경로를 선택할 수 있는 변경 스토리지 경로 창을 엽니다.그림 3.3.

스토리지 경로창 변경

게스트 가상 머신 복제

Clone (복제)을 클릭합니다.

4장. KVM 실시간 마이그레이션

- 부하 분산 - 호스트 물리적 시스템이 과부하되거나 다른 호스트 물리적 시스템이 활용도가 낮은 사용량을 사용하여 게스트 가상 시스템을 호스트할 수 있습니다.

- 하드웨어 독립성 - 호스트 물리적 시스템에서 하드웨어 장치를 업그레이드, 추가 또는 제거해야 하는 경우 게스트 가상 머신을 다른 호스트 물리적 시스템으로 안전하게 재배치할 수 있습니다. 즉, 게스트 가상 머신은 하드웨어 개선을 위해 다운타임이 발생하지 않습니다.

- 에너지 절약 - 게스트 가상 머신은 다른 호스트 물리적 시스템에 재배포될 수 있으므로 전력을 절약하고 사용 기간에 비용을 절감할 수 있습니다.

- 지리적 마이그레이션 - 대기 시간이 낮거나 심각한 상황에서 게스트 가상 머신을 다른 위치로 이동할 수 있습니다.

4.1. 실시간 마이그레이션 요구 사항

마이그레이션 요구 사항

- 다음 프로토콜 중 하나를 사용하여 공유 스토리지에 설치된 게스트 가상 머신:

- 파이버 채널 기반 LUN

- iSCSI

- FCoE

- NFS

- GFS2

- SCSI RDMA 프로토콜(SCSI RCP): Infiniband 및 10GbE iWARP 어댑터에 사용되는 블록 내보내기 프로토콜

- 마이그레이션 플랫폼 및 버전은 표 4.1. “실시간 마이그레이션 호환성” 테이블에 대해 확인해야 합니다. 또한 Red Hat Enterprise Linux 6는 공유 스토리지에서 raw 및 qcow2 이미지를 사용하여 게스트 가상 시스템의 실시간 마이그레이션을 지원합니다.

- 두 시스템 모두 적절한 TCP/IP 포트가 열려 있어야 합니다. 방화벽을 사용하는 경우 자세한 포트 정보는 에서 확인할 https://access.redhat.com/site/documentation/ 수 있는 Red Hat Enterprise Linux Virtualization Security 가이드 를 참조하십시오.

- 공유 스토리지 매체를 내보내는 개별 시스템입니다. 마이그레이션에 사용되는 두 호스트 물리적 시스템 중 하나에 스토리지가 없어야 합니다.

- 공유 스토리지는 소스 및 대상 시스템의 동일한 위치에 마운트해야 합니다. 마운트된 디렉터리 이름은 동일해야 합니다. 이미지를 다른 경로를 사용하여 유지할 수 있지만 권장되지는 않습니다. virt-manager를 사용하여 마이그레이션을 수행하려는 경우 경로 이름이 동일해야 합니다. 그러나 virsh를 사용하여 마이그레이션을 수행하려는 경우 마이그레이션을 수행할 때 --xml 옵션 또는 pre-hooks와 함께 다른 네트워크 구성 및 마운트 디렉토리를 사용할 수 있습니다. 공유 스토리지가 없어도 --copy-storage-all (더 이상 사용되지 않음) 옵션을 사용하여 마이그레이션이 성공할 수 있습니다. prehooks 에 대한 자세한 내용은 libvirt.org 를 참조하고 XML 옵션에 대한 자세한 내용은 20장. 도메인 XML 조작 을 참조하십시오.

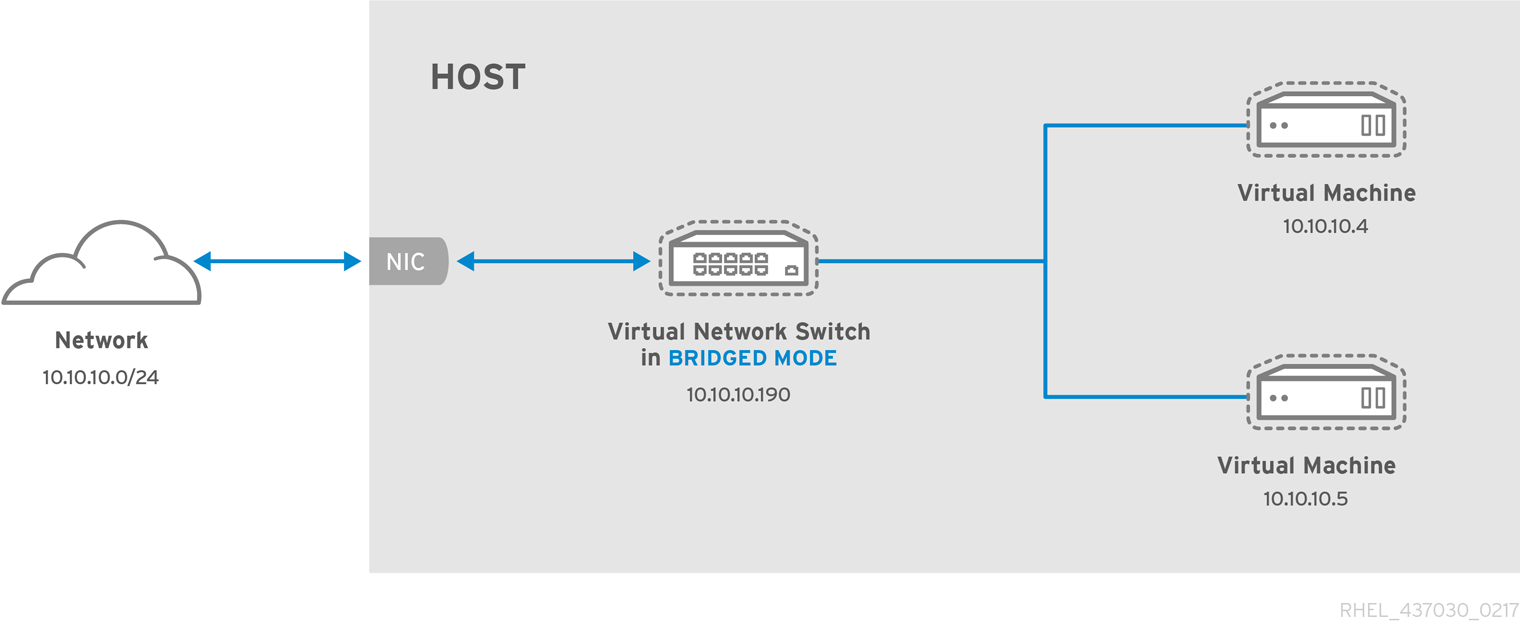

- 공용 bridge+tap 네트워크의 기존 게스트 가상 시스템에서 마이그레이션을 시도하는 경우 소스 및 대상 호스트 물리적 시스템이 동일한 네트워크에 있어야 합니다. 그렇지 않으면 마이그레이션 후 게스트 가상 머신 네트워크가 작동하지 않습니다.

- Red Hat Enterprise Linux 5 및 6에서는 KVM 게스트 가상 머신의 기본 캐시 모드가

none으로 설정되어 일치하지 않는 디스크 상태를 방지합니다. 캐시 옵션을none(예: virsh attach-disk 캐시 사용)으로 설정하면O_DIRECT플래그( Open syscall을 호출할 때)를 사용하여 모든 게스트 가상 시스템의 파일이 열리 므로 호스트 물리적 시스템의 캐시를 우회하고 게스트 가상 시스템에서 캐싱만 제공합니다. 캐시 모드를none으로 설정하면 잠재적인 불일치 문제를 방지하고 가상 시스템을 실시간으로 마이그레이션할 수 있습니다. 캐시를none으로 설정하는 방법에 대한 자세한 내용은 13.3절. “게스트에 스토리지 장치 추가” 을 참조하십시오.

libvirtd 서비스가 활성화되어 있는지 확인합니다(#service libvirtd 시작). 또한 효과적으로 마이그레이션하는 기능은 /etc/libvirt/libvirtd.conf 설정 파일의 매개 변수 설정에 따라 달라집니다.

절차 4.1. libvirtd.conf 구성

libvirtd.conf를 열려면 root로 명령을 실행해야 합니다.vim /etc/libvirt/libvirtd.conf

# vim /etc/libvirt/libvirtd.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 필요에 따라 매개변수를 변경하고 파일을 저장합니다.

libvirtd서비스를 다시 시작합니다.service libvirtd restart

# service libvirtd restartCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2. 실시간 마이그레이션 및 Red Hat Enterprise Linux 버전 호환성

| 마이그레이션 방법 | 릴리스 유형 | 예제 | 실시간 마이그레이션 지원 | 참고 |

|---|---|---|---|---|

| forward | 메이저 릴리스 | 5.x → 6.y | 지원되지 않음 | |

| forward | 마이너 릴리스 | 5.x → 5.y (y>x, x>=4) | 모두 지원됨 | 모든 문제가 보고되어야 합니다. |

| forward | 마이너 릴리스 | 6.x → 6.y (y>x, x>=0) | 모두 지원됨 | 모든 문제가 보고되어야 합니다. |

| 이전 | 메이저 릴리스 | 6.x → 5.y | 지원되지 않음 | |

| 이전 | 마이너 릴리스 | 5.x → 5.y (x>y,y>=4) | 지원됨 | 알려진 문제는 마이그레이션 문제 해결 에서 참조하십시오. |

| 이전 | 마이너 릴리스 | 6.x → 6.y (x>y, y>=0) | 지원됨 | 알려진 문제는 마이그레이션 문제 해결 에서 참조하십시오. |

마이그레이션 문제 해결

- SPICE 관련 문제 - Red Hat Enterprise Linux 6.0 → 6.1에서 마이그레이션할 때 SPICE에 호환되지 않는 변경 사항이 있음을 확인했습니다. 이러한 경우 클라이언트는 연결을 끊은 다음 다시 연결하여 오디오 및 비디오의 일시적인 손실을 초래할 수 있습니다. 이는 일시적인 것이며 모든 서비스가 다시 시작됩니다.

- USB 문제 - Red Hat Enterprise Linux 6.2는 마이그레이션 지원을 포함한 USB 기능을 추가했지만 USB 장치를 재설정하고 장치를 통해 실행되는 애플리케이션을 중단시키는 특정 경고가 발생하지 않았습니다. 이 문제는 Red Hat Enterprise Linux 6.4에서 해결되었으며 향후 버전에서는 발생하지 않아야 합니다. 6.4 이전 버전에서 이러한 문제가 발생하지 않도록하기 위해 USB 장치를 사용하는 동안 마이그레이션을 유도합니다.

- 마이그레이션 프로토콜 문제 - 이전 마이그레이션이 "알리지 않은 섹션 오류"로 끝나는 경우 마이그레이션 프로세스를 반복하면 일시적인 오류일 수 있으므로 마이그레이션 프로세스를 반복할 수 있습니다. 그렇지 않은 경우 문제를 보고하십시오.

네트워크 스토리지 구성

공유 스토리지를 구성하고 공유 스토리지에 게스트 가상 머신을 설치합니다.

4.4. virsh를 통한 실시간 KVM 마이그레이션

virsh migrate --live GuestName DestinationURL

# virsh migrate --live GuestName DestinationURL--live 옵션이 제거될 수 있습니다. 추가 옵션은 4.4.2절. “virsh migrate 명령에 대한 추가 옵션” 에 나열됩니다.

GuestName 매개변수는 마이그레이션할 게스트 가상 머신의 이름을 나타냅니다.

DestinationURL 매개변수는 대상 호스트 물리적 시스템의 연결 URL입니다. 대상 시스템은 동일한 하이퍼바이저를 사용하고 libvirt 가 실행되고 있는 동일한 버전의 Red Hat Enterprise Linux를 실행해야 합니다.

DestinationURL 매개변수는 다른 의미가 있습니다.

- 일반 마이그레이션:

DestinationURL은 소스 게스트 가상 머신에 표시된 대로 대상 호스트 물리적 시스템의 URL입니다. - 피어 투 피어 마이그레이션:

DestinationURL은 소스 호스트 물리적 시스템에서 표시된 대로 대상 호스트 물리적 시스템의 URL입니다.

/etc/hosts 파일에 있는 대상 호스트 물리적 시스템에 대한 항목이 필요합니다. 다음 예에 표시된 대로 이 파일에서 대상 호스트 물리적 시스템의 IP 주소 및 호스트 이름을 입력합니다. 이 예에서는 대상 호스트 물리적 시스템의 IP 주소와 호스트 이름을 대체합니다.

10.0.0.20 host2.example.com

10.0.0.20 host2.example.com

예: virsh를 사용한 실시간 마이그레이션

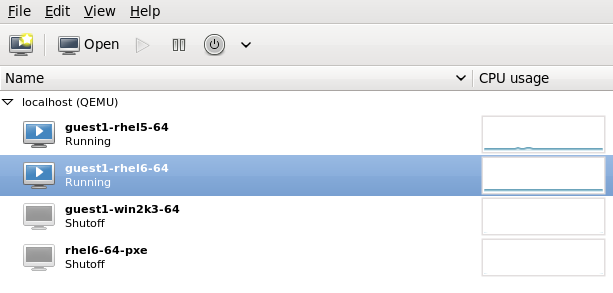

이 예에서는 host1.example.com 에서 host2.example.com 으로 마이그레이션합니다. 환경의 호스트 물리적 시스템 이름을 변경합니다. 이 예에서는 guest1-rhel6-64 라는 가상 머신을 마이그레이션합니다.

게스트 가상 머신이 실행 중인지 확인

소스 시스템host1.example.com에서guest1-rhel6-64가 실행 중인지 확인합니다.virsh list Id Name State ---------------------------------- 10 guest1-rhel6-64 running

[root@host1 ~]# virsh list Id Name State ---------------------------------- 10 guest1-rhel6-64 runningCopy to Clipboard Copied! Toggle word wrap Toggle overflow 게스트 가상 머신 마이그레이션

다음 명령을 실행하여 게스트 가상 머신을 대상host2.example.com으로 실시간 마이그레이션합니다. libvirt에 전체 액세스 권한이 필요함을 확인하기 위해 대상 URL의 끝에/system을 추가합니다.virsh migrate --live guest1-rhel6-64 qemu+ssh://host2.example.com/system

# virsh migrate --live guest1-rhel6-64 qemu+ssh://host2.example.com/systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 명령을 입력하면 대상 시스템의 루트 암호를 입력하라는 메시지가 표시됩니다.wait

마이그레이션은 게스트 가상 시스템의 로드 및 크기에 따라 다소 시간이 걸릴 수 있습니다. virsh 는 오류만 보고합니다. 게스트 가상 시스템은 완전히 마이그레이션될 때까지 소스 호스트 물리적 시스템에서 계속 실행됩니다.참고마이그레이션 중에 완료 백분율 표시 수는 프로세스가 완료되기 전에 여러 번 감소할 수 있습니다. 이는 마이그레이션을 시작한 후 변경된 소스 메모리 페이지를 다시 복사해야 하므로 전체 진행 상황을 다시 계산하기 때문입니다. 따라서 이 동작이 예상되며 마이그레이션에 문제가 표시되지 않습니다.게스트 가상 머신이 대상 호스트에 도착했는지 확인합니다.

대상 시스템host2.example.com에서guest1-rhel6-64가 실행 중인지 확인합니다.virsh list Id Name State ---------------------------------- 10 guest1-rhel6-64 running

[root@host2 ~]# virsh list Id Name State ---------------------------------- 10 guest1-rhel6-64 runningCopy to Clipboard Copied! Toggle word wrap Toggle overflow

virsh dumpxml Guest1 > Guest1.xml virsh -c qemu+ssh://<target-system-FQDN> define Guest1.xml virsh undefine Guest1

virsh dumpxml Guest1 > Guest1.xml

virsh -c qemu+ssh://<target-system-FQDN> define Guest1.xml

virsh undefine Guest1

4.4.1. virsh로 마이그레이션에 대한 추가 팁

- 절차 4.1. “libvirtd.conf 구성” 에 설명된 대로 libvirtd.conf 파일을 엽니다.

- 처리 제어 섹션을 찾습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow max_clients및max_workers매개 변수 설정을 변경합니다. 두 매개변수 모두에서 숫자가 동일해야 합니다.max_clients는 마이그레이션당 2개의 클라이언트를 사용하고max_workers는 종료 단계에서 수행 단계에서 대상의 작업자 1명과 대상의 작업자 1개를 소스에 사용합니다.중요max_clients및max_workers매개 변수 설정은 libvirtd 서비스에 대한 모든 게스트 가상 머신 연결에 적용됩니다. 즉, 동일한 게스트 가상 머신을 사용하고 동시에 마이그레이션을 수행하는 모든 사용자는max_clients및max_workers매개 변수 설정에 설정된 제한으로도 보류됩니다. 따라서 동시 실시간 마이그레이션을 수행하기 전에 최대값을 주의 깊게 고려해야 합니다.- 파일을 저장하고 서비스를 다시 시작합니다.참고시작되었지만 아직 인증되지 않은 ssh 세션이 너무 많기 때문에 마이그레이션 연결이 끊어지는 경우가 있을 수 있습니다. 기본적으로

sshd는 언제든지 "사전 인증됨"에 있는 세션만 10개를 허용합니다. 이 설정은 sshd 구성 파일의MaxStartups매개변수(/etc/ssh/sshd_config)에 의해 제어되며 일부 조정이 필요할 수 있습니다. DoS 공격을 방지하기 위해 제한 사항이 배치되고 일반적으로 리소스를 과도하게 사용할 수 있으므로 이 매개변수를 조정하는 작업은 주의해야 합니다. 이 값을 너무 높게 설정하면 목적을 무효화합니다. 이 매개변수를 변경하려면/etc/ssh/sshd_config파일을 편집하고 MaxStartups 행의 시작 위치에서 # 을 제거하고,10(기본값)을 더 높은 숫자로 변경합니다. 파일을 저장하고sshd서비스를 다시 시작하십시오. 자세한 내용은sshd_config매뉴얼 페이지를 참조하십시오.

4.4.2. virsh migrate 명령에 대한 추가 옵션

--live 외에도 virsh migrate는 다음 옵션을 허용합니다.

--direct- 직접 마이그레이션에 사용--p2p- 피어 투 피어 마이그레이션에 사용--tunnelled- 터널링된 마이그레이션에 사용--persistent- 대상 호스트 물리적 시스템의 영구 상태로 도메인을 유지합니다.--undefinesource- 소스 호스트 물리적 시스템에서 게스트 가상 머신 제거--suspend- 대상 호스트 물리적 머신의 일시 정지 상태로 둡니다.--change-protection- 마이그레이션이 진행되는 동안 도메인에 호환되지 않는 구성 변경이 수행되지 않도록 강제 적용합니다. 하이퍼바이저에서 이 옵션을 암시적으로 활성화하지만 하이퍼바이저에 변경 보호 지원이 없는 경우 이 옵션을 명시적으로 사용하여 마이그레이션을 거부할 수 있습니다.--unsafe- 모든 안전 절차를 무시하고 마이그레이션을 강제 실행합니다.--verbose- 발생 시 마이그레이션 진행 상황을 표시합니다.--abort-on-error- 마이그레이션 프로세스 중에 소프트 오류(예: I/O 오류)가 발생하는 경우 마이그레이션을 취소합니다.--migrateuri- 일반적으로 생략된 마이그레이션 URI입니다.--domain[string]- 도메인 이름, ID 또는 uuid--desturi[string]- 클라이언트(정상 마이그레이션) 또는 source(p2p 마이그레이션)에서 표시된 대로 대상 호스트 물리적 시스템의 연결 URI--migrateuri- 마이그레이션 URI, 일반적으로 생략할 수 있습니다.--timeout[seconds]- 실시간 마이그레이션 카운터가 N초를 초과하면 게스트 가상 머신이 강제로 일시 중지됩니다. 실시간 마이그레이션에서만 사용할 수 있습니다. 제한 시간이 시작되면 일시 중단된 게스트 가상 머신에서 마이그레이션이 계속됩니다.--DNAME [string] - 마이그레이션 중에 게스트 가상 머신의 이름을 새 이름으로 변경합니다(지원되는 경우)--XML - 표시된 파일 이름은 기본 스토리지에 액세스하는 소스와 대상 간의 이름 지정 차이점과 같이 도메인 XML의 호스트별 부분에 대한 더 큰 변경 집합을 제공하기 위해 대상에 사용할 대체 XML 파일을 제공하는 데 사용할 수 있습니다. 이 옵션은 일반적으로 생략됩니다.

4.5. virt-manager로 마이그레이션

virt-manager를 엽니다.

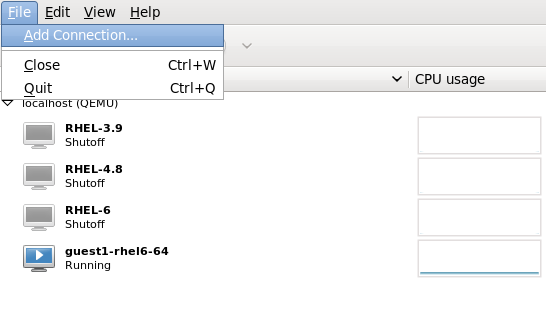

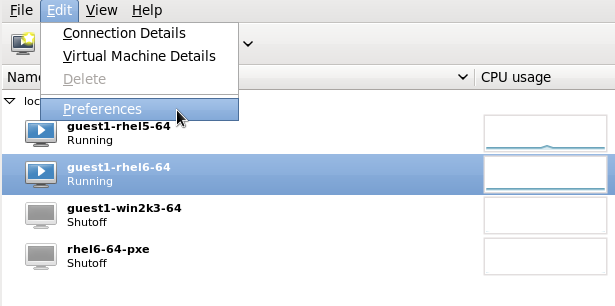

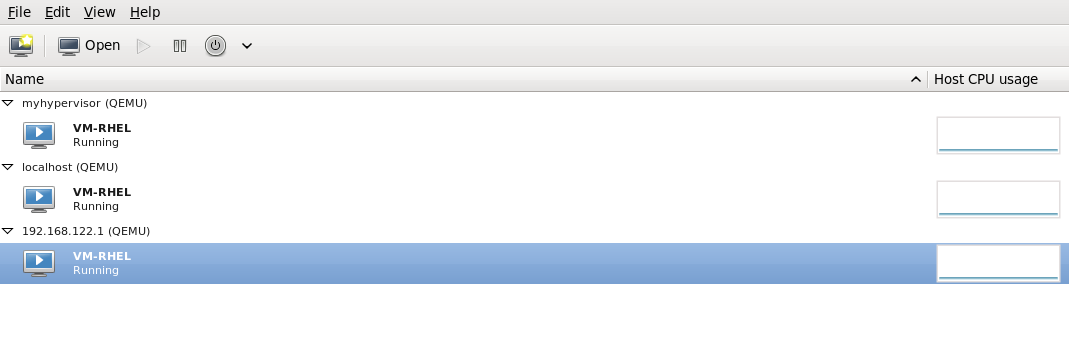

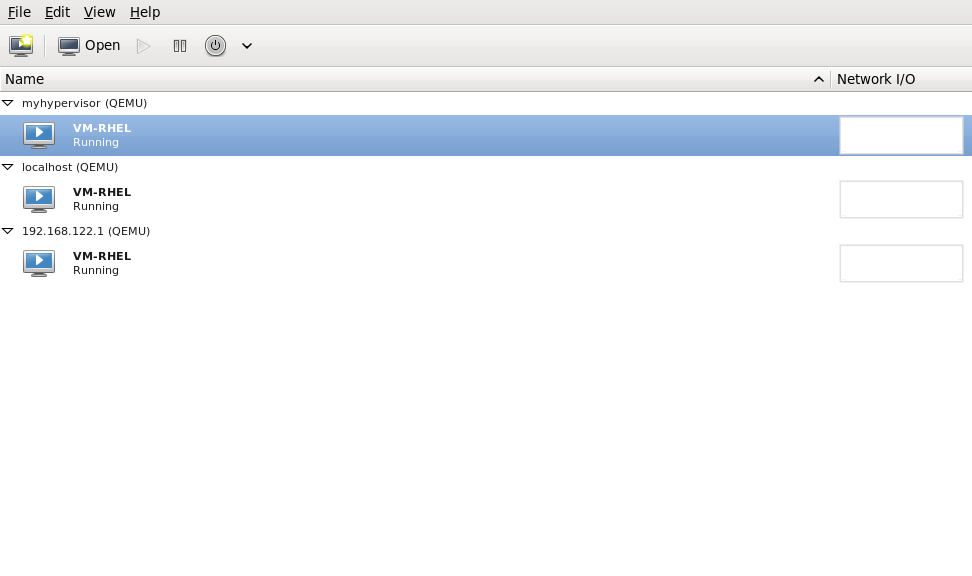

virt-manager 를 엽니다. 메인 메뉴 모음에서 → → 를 선택하여 virt-manager 를 시작합니다.그림 4.1. virt-Manager 메인 메뉴

대상 호스트 물리적 머신에 연결

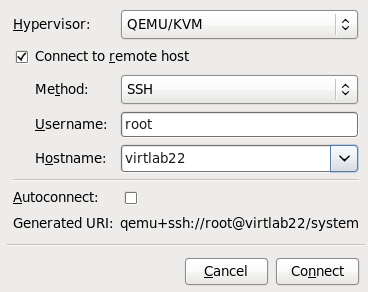

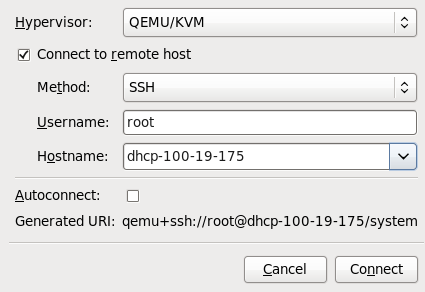

메뉴를 클릭하여 대상 호스트 물리적 시스템에 연결한 다음 를 클릭합니다.그림 4.2. 연결 추가 창을 엽니다.

연결 추가

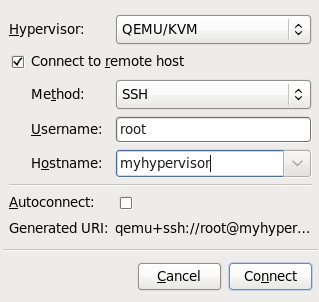

연결 추가 창이 나타납니다.그림 4.3. 대상 호스트 물리적 머신에 연결 추가

다음 세부 정보를 입력합니다.

다음 세부 정보를 입력합니다.- 하이퍼바이저: 을 선택합니다.

- 방법: 연결 방법을 선택합니다.

- username: 원격 호스트 물리적 머신의 사용자 이름을 입력합니다.

- hostname: 원격 호스트 물리적 머신의 호스트 이름을 입력합니다.

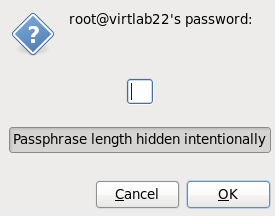

버튼을 클릭합니다. 이 예에서는 SSH 연결이 사용되므로 다음 단계에서 지정된 사용자의 암호를 입력해야 합니다.그림 4.4. 암호 입력

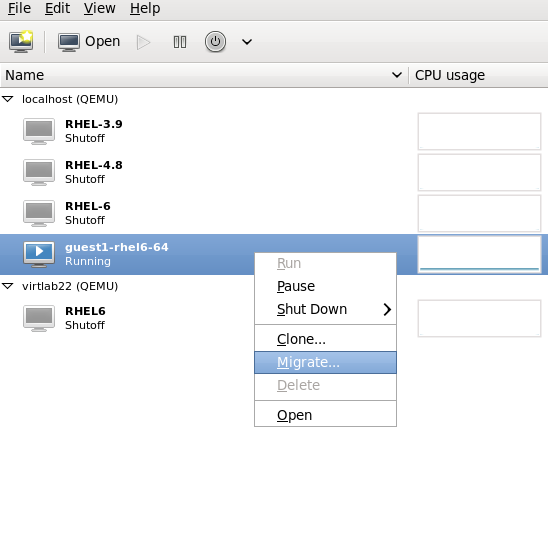

게스트 가상 머신 마이그레이션

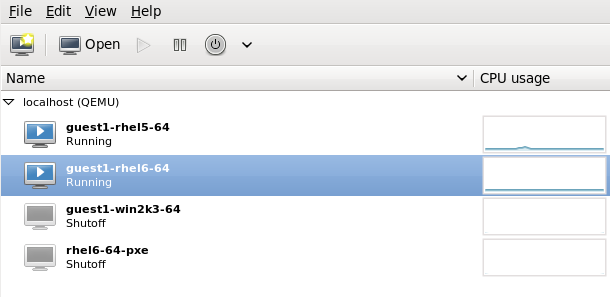

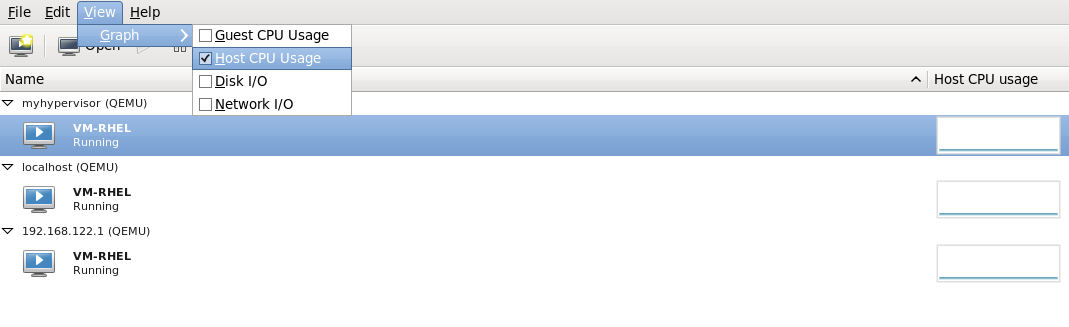

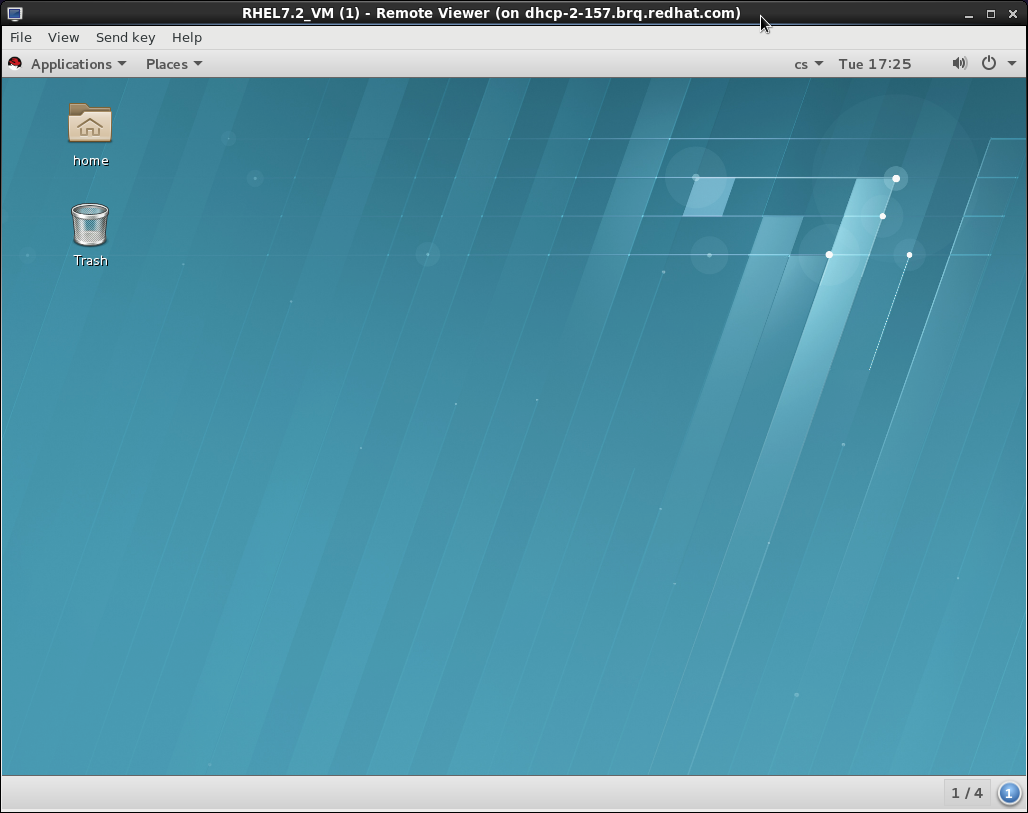

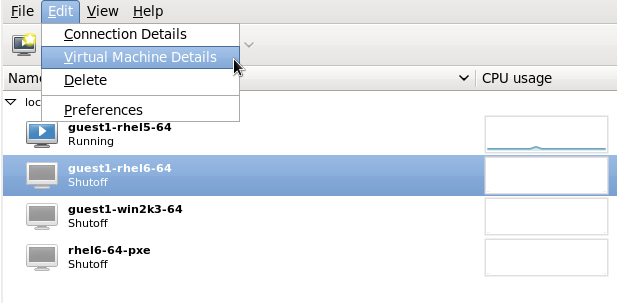

소스 호스트 물리적 시스템 내의 게스트 목록을 열고(호스트 이름의 왼쪽에 있는 작은 삼각형을 클릭) 마이그레이션할 게스트(이 예제에서는guest1-rhel 6-64)를 마우스 오른쪽 버튼으로 클릭하고 을 클릭합니다.그림 4.5. 마이그레이션할 게스트 선택

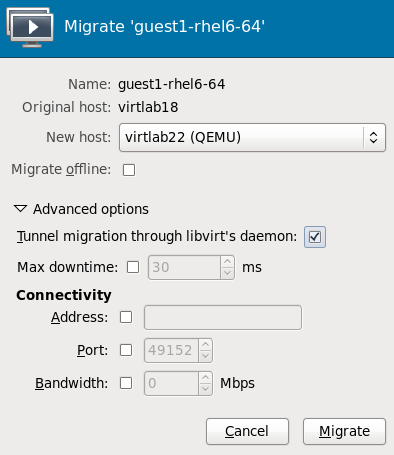

(새 호스트) 필드에서 드롭다운 목록을 사용하여 guest 가상 머신을 마이그레이션할 호스트 물리적 시스템을 선택하고 마이그레이션을 .

(새 호스트) 필드에서 드롭다운 목록을 사용하여 guest 가상 머신을 마이그레이션할 호스트 물리적 시스템을 선택하고 마이그레이션을 .그림 4.6. 대상 호스트 물리적 시스템 선택 및 마이그레이션 프로세스 시작

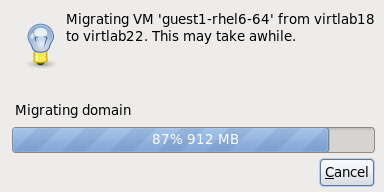

진행률 창이 나타납니다.

진행률 창이 나타납니다.그림 4.7. 진행률 창

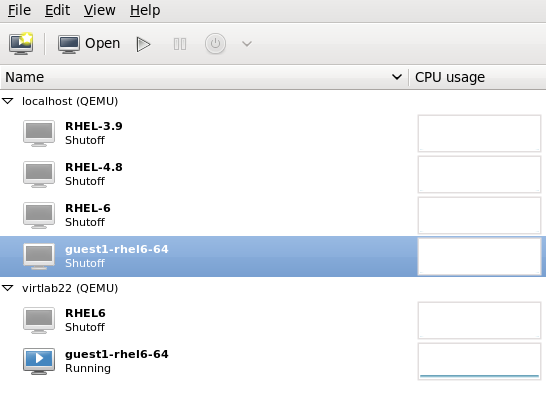

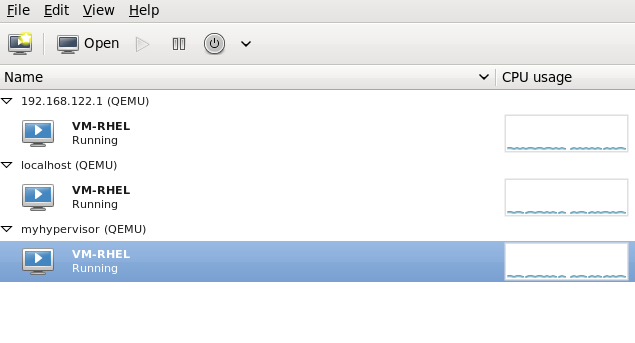

virt-manager 가 대상 호스트에서 실행 중인 새로 마이그레이션된 게스트 가상 머신을 표시합니다. 이제 소스 호스트 물리적 시스템에서 실행 중인 게스트 가상 머신이 Shutoff 상태에 나열됩니다.

virt-manager 가 대상 호스트에서 실행 중인 새로 마이그레이션된 게스트 가상 머신을 표시합니다. 이제 소스 호스트 물리적 시스템에서 실행 중인 게스트 가상 머신이 Shutoff 상태에 나열됩니다.그림 4.8. 대상 호스트 물리적 머신에서 실행 중인 마이그레이션된 게스트 가상 머신

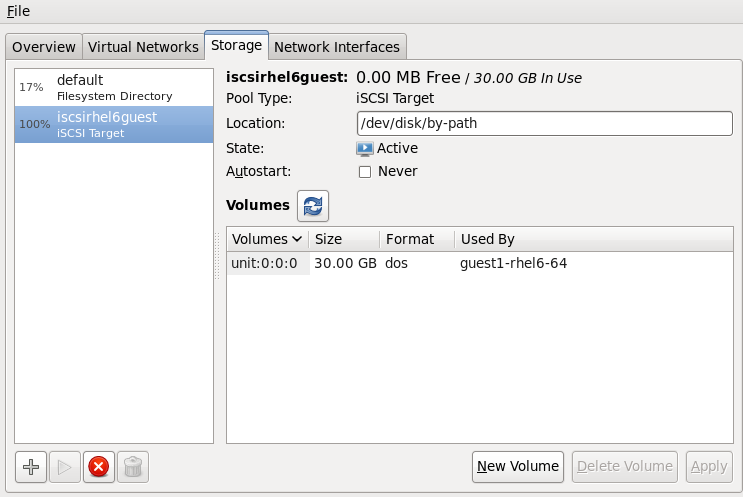

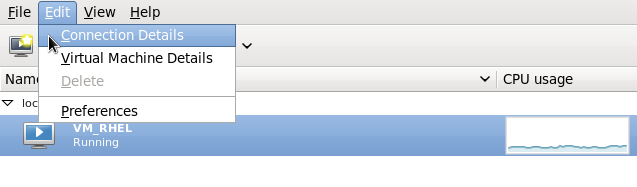

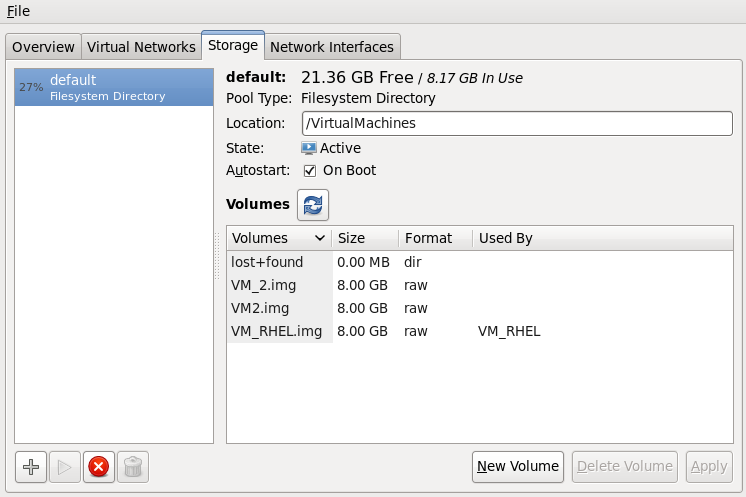

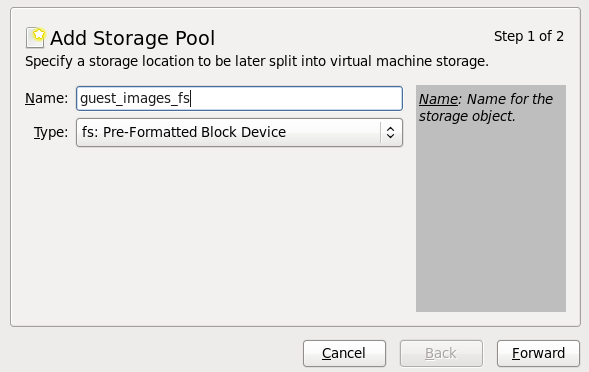

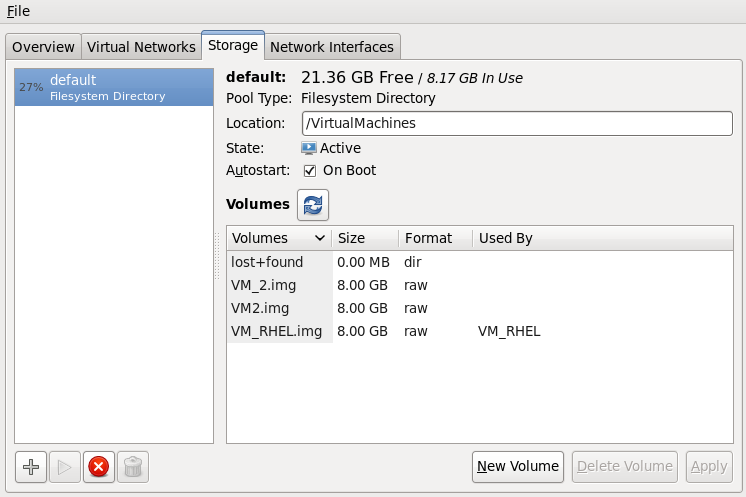

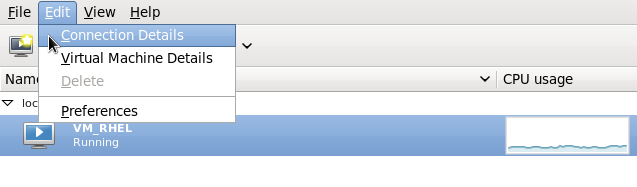

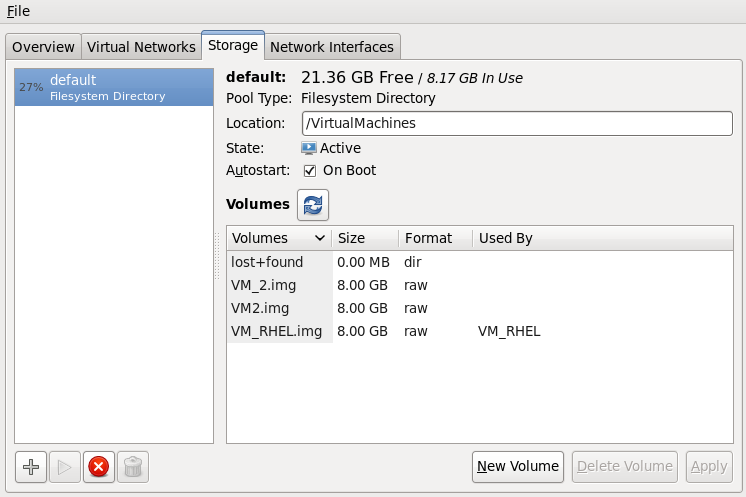

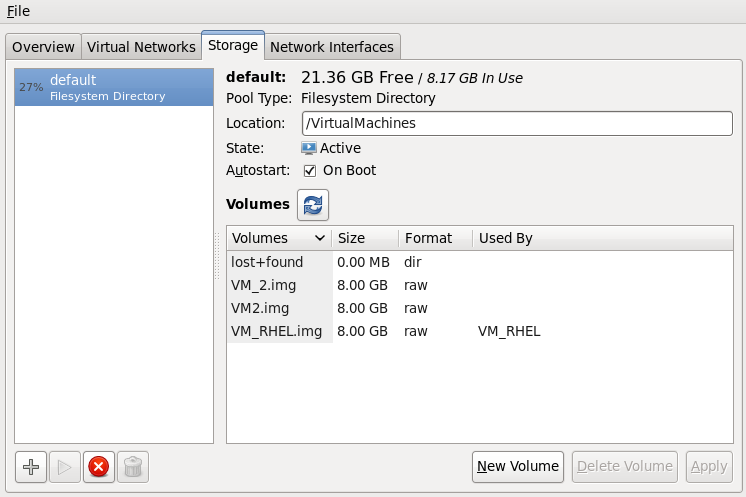

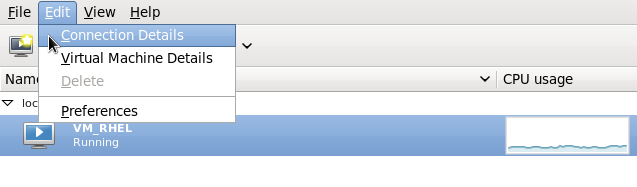

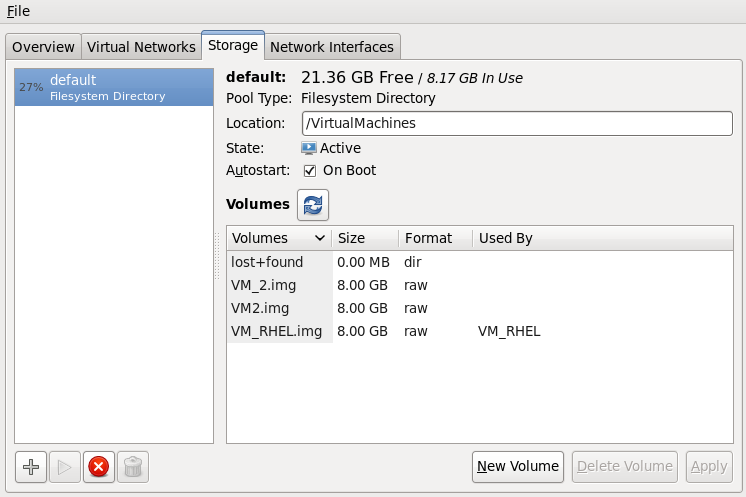

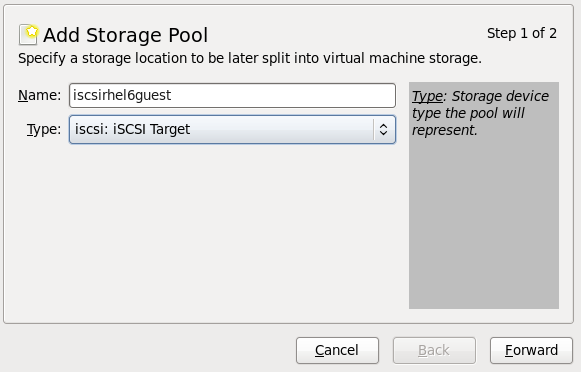

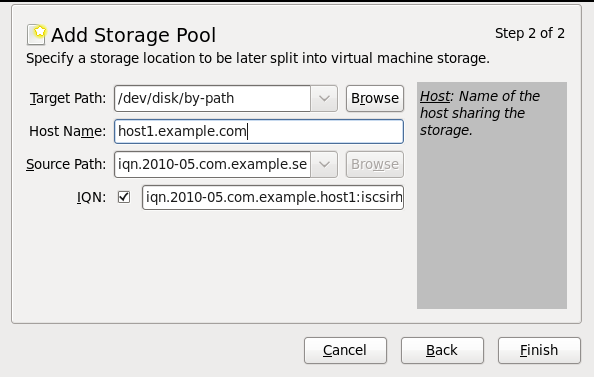

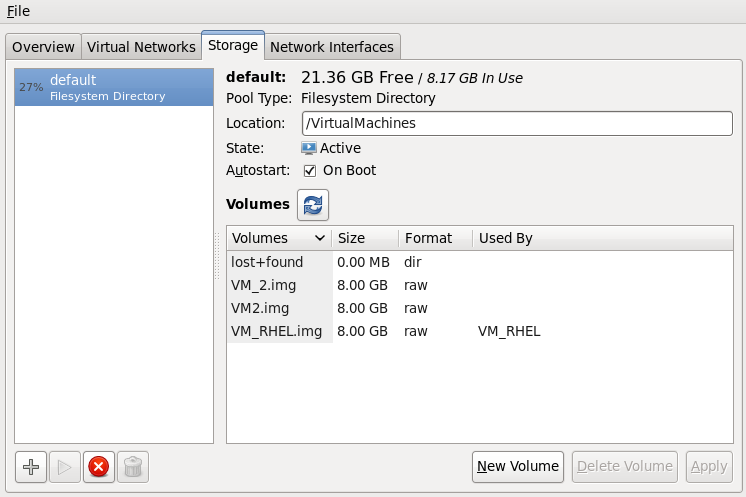

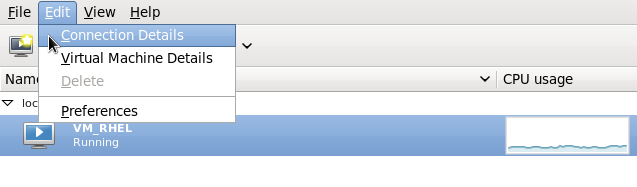

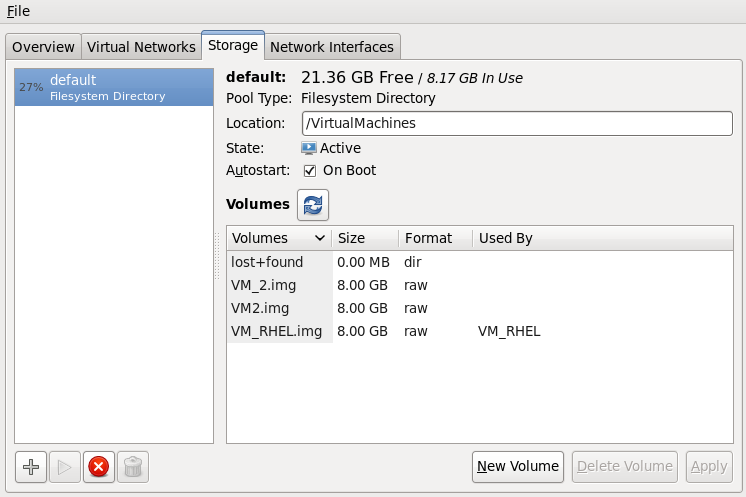

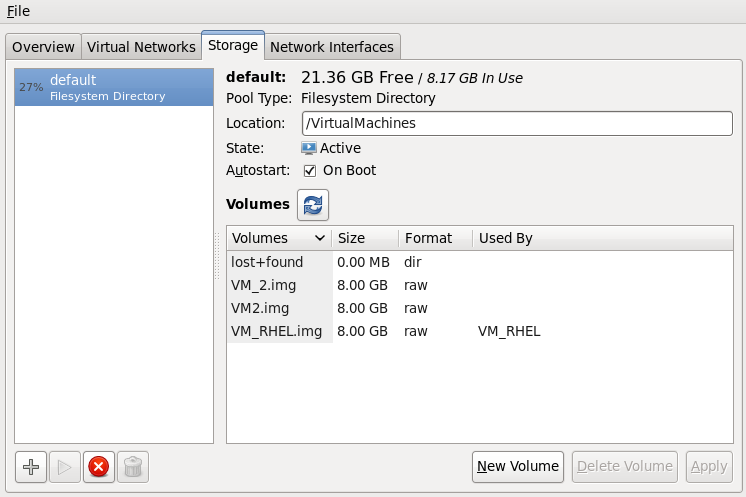

선택 사항 - 호스트 물리적 머신의 스토리지 세부 정보 보기

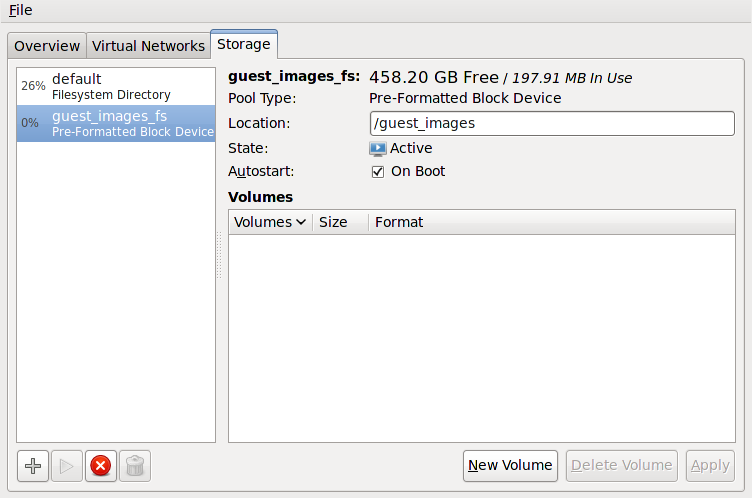

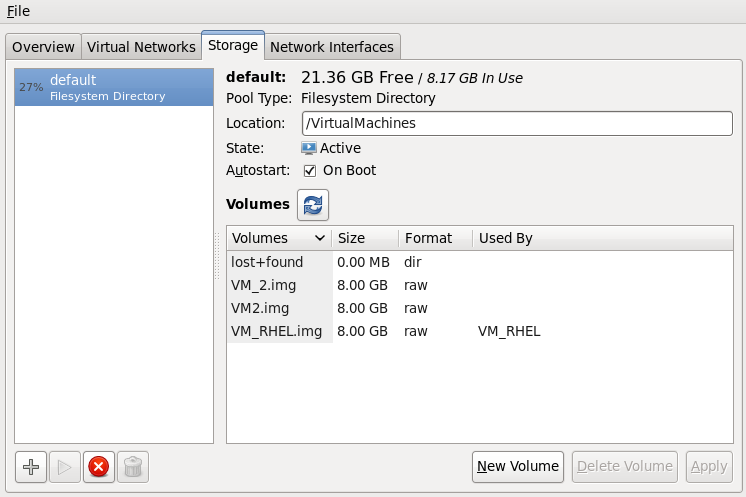

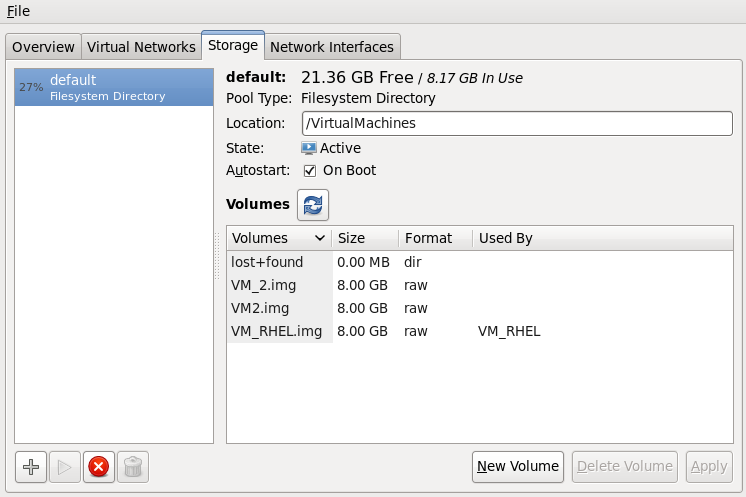

메뉴에서 연결 세부 정보를 클릭하면 정보 창이 표시됩니다.탭을 클릭합니다. 대상 호스트 물리적 시스템의 iSCSI 대상 세부 정보가 표시됩니다. 마이그레이션된 게스트 가상 머신은 스토리지를 사용하여 로 나열됩니다.그림 4.9. 스토리지 세부 정보

이 호스트는 다음 XML 구성으로 정의되었습니다.

이 호스트는 다음 XML 구성으로 정의되었습니다.그림 4.10. 대상 호스트 물리적 머신의 XML 구성

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5장. 원격 게스트 관리

5.1. SSH를 사용한 원격 관리

- 가상 머신 관리를 위해 원격 시스템에 root가 로그인해야 합니다.

- 초기 연결 설정 프로세스가 느릴 수 있습니다.

- 모든 호스트 또는 게스트에서 사용자의 키를 취소하는 표준 또는 간단한 방법은 없습니다.

- SSH는 원격 머신 수가 많으면 제대로 확장되지 않습니다.

- openssh

- openssh-askpass

- openssh-clients

- openssh-server

virt-manager에 대한 암호 없는 또는 암호 관리 SSH 액세스 구성

다음 지침은 처음부터 시작 중이며 SSH 키가 아직 설정되어 있지 않다고 가정합니다. SSH 키를 설정하고 다른 시스템에 복사한 경우 이 절차를 건너뛸 수 있습니다.

선택 사항: 사용자 변경

필요한 경우 사용자를 변경합니다. 이 예에서는 로컬 root 사용자를 사용하여 다른 호스트 및 로컬 호스트를 원격으로 관리합니다.su -

$ su -Copy to Clipboard Copied! Toggle word wrap Toggle overflow SSH 키 쌍 생성

virt-manager 가 사용되는 시스템에서 공개 키 쌍을 생성합니다. 이 예에서는~/.ssh/디렉터리의 기본 키 위치를 사용합니다.ssh-keygen -t rsa

# ssh-keygen -t rsaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 원격 호스트에 키 복사

암호 없이 원격 로그인하거나 암호를 사용하는 경우 SSH 키를 관리 중인 시스템에 배포해야 합니다. ssh-copy-id 명령을 사용하여 제공된 시스템 주소(예:root@host2.example.com)에서 root 사용자에게 키를 복사합니다.ssh-copy-id -i ~/.ssh/id_rsa.pub root@host2.example.com root@host2.example.com's password:

# ssh-copy-id -i ~/.ssh/id_rsa.pub root@host2.example.com root@host2.example.com's password:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이제 ssh root@host2.example.com 명령을 사용하여 머신에 로그인하고.ssh/authorized_keys파일을 확인하여 예기치 않은 키가 추가되지 않았는지 확인합니다.필요에 따라 다른 시스템에 대해 반복합니다.선택사항: ssh-agent에 암호를 추가합니다.

아래 지침은 기존 ssh-agent에 암호를 추가하는 방법을 설명합니다. ssh-agent가 실행되고 있지 않으면 실행되지 않습니다. 오류 또는 충돌을 방지하려면 SSH 매개 변수가 올바르게 설정되어 있는지 확인합니다. 자세한 내용은 Red Hat Enterprise Linux 배포 가이드 를 참조하십시오.필요한 경우 SSH 키의 암호를 ssh-agent 에 추가합니다. 로컬 호스트에서 다음 명령을 사용하여 암호 없이 로그인할 수 있도록 암호를 추가합니다.ssh-add ~/.ssh/id_rsa

# ssh-add ~/.ssh/id_rsaCopy to Clipboard Copied! Toggle word wrap Toggle overflow SSH 키가 원격 시스템에 추가됩니다.

libvirt 데몬(libvirtd)

libvirt 데몬은 가상 머신을 관리하기 위한 인터페이스를 제공합니다. 관리를 필요로 하는 모든 원격 호스트에 libvirtd 데몬이 설치되어 실행되고 있어야 합니다.

ssh root@somehost chkconfig libvirtd on service libvirtd start

$ ssh root@somehost

# chkconfig libvirtd on

# service libvirtd startlibvirtd 및 SSH 가 구성된 후 가상 시스템에 원격으로 액세스하고 관리할 수 있어야 합니다. 이 시점에서 VNC 를 사용하여 게스트에 액세스할 수도 있습니다.

virt-manager를 사용하여 원격 호스트에 액세스

virt-manager GUI 도구를 사용하여 원격 호스트를 관리할 수 있습니다. 암호 없이 로그인할 수 있으려면 SSH 키는 virt-manager를 실행하는 사용자에 속해야 합니다.

- virt-manager를 시작합니다.

- -> 메뉴를 엽니다.

그림 5.1. 연결 메뉴 추가

- 드롭다운 메뉴를 사용하여 하이퍼바이저 유형을 선택하고, 확인란을 클릭하여 Connection (이 경우 SSH를 통한 원격 터널)를 열고 원하는 입력한 다음 클릭합니다.

5.2. TLS 및 SSL을 통한 원격 관리

절차 5.1. TLS 관리를 위한 인증 기관(CA) 키 생성

- 시작하기 전에 certtool 유틸리티가 설치되었는지 확인합니다. 그렇지 않은 경우:

yum install gnutls-utils

# yum install gnutls-utilsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 다음 명령을 사용하여 개인 키를 생성합니다.

certtool --generate-privkey > cakey.pem

# certtool --generate-privkey > cakey.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 키가 생성되면 다음 단계는 서명 파일을 작성하여 키를 자체 서명할 수 있도록 하는 것입니다. 이렇게 하려면 서명 세부 정보가 있는 파일을 생성하고 이름을

ca.info로 지정합니다. 이 파일에는 다음이 포함되어야 합니다.vim ca.info

# vim ca.infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow cn = Name of your organization ca cert_signing_key

cn = Name of your organization ca cert_signing_keyCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 다음 명령을 사용하여 자체 서명 키를 생성합니다.

certtool --generate-self-signed --load-privkey cakey.pem --template ca.info --outfile cacert.pem

# certtool --generate-self-signed --load-privkey cakey.pem --template ca.info --outfile cacert.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일이 생성되면 rm 명령을 사용하여 ca.info 파일을 삭제할 수 있습니다. 생성 프로세스에서 발생하는 파일의 이름은cacert.pem입니다. 이 파일은 공개 키(certificate)입니다. 로드된 파일cakey.pem은 개인 키입니다. 이 파일은 공유 공간에 보관해서는 안 됩니다. 이 키를 비공개로 유지합니다. /etc/pki/CA/cacert.pem디렉터리의 모든 클라이언트 및 서버에cacert.pem인증 인증 인증서 파일을 설치하여 CA에서 발급한 인증서를 신뢰할 수 있도록 합니다. 이 파일의 내용을 보려면 다음을 실행합니다.certtool -i --infile cacert.pem

# certtool -i --infile cacert.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이는 CA를 설정하는 데 필요한 모든 것입니다. 클라이언트 및 서버의 인증서를 발급하려면 CA의 개인 키를 안전하게 보관해야 합니다.

절차 5.2. 서버 인증서 발급

qemu://mycommonname/system 을 사용하여 서버에 연결하므로 CN 필드가 동일해야 합니다.

- 서버에 대한 개인 키를 만듭니다.

certtool --generate-privkey > serverkey.pem

# certtool --generate-privkey > serverkey.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow server.info.info라는 템플릿 파일을 먼저 생성하여 CA의 개인 키 서명을 생성합니다. CN이 서버의 호스트 이름과 동일하게 설정되어 있는지 확인합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 다음 명령을 사용하여 인증서를 생성합니다.

certtool --generate-certificate --load-privkey serverkey.pem --load-ca-certificate cacert.pem --load-ca-privkey cakey.pem \ --template server.info --outfile servercert.pem

# certtool --generate-certificate --load-privkey serverkey.pem --load-ca-certificate cacert.pem --load-ca-privkey cakey.pem \ --template server.info --outfile servercert.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 그러면 두 개의 파일이 생성됩니다.

- serverkey.pem - 서버의 개인 키

- servercert.pem - 서버의 공개 키

개인 키의 위치를 비밀로 유지합니다. 파일의 내용을 보려면 다음 명령을 수행합니다.certtool -i --inifile servercert.pem

# certtool -i --inifile servercert.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 파일을 열 때CN=매개변수는 이전에 설정한 CN과 동일해야 합니다. 예를 들면mycommonname입니다. - 다음 위치에 두 파일을 설치합니다.

serverkey.pem- 서버의 개인 키입니다. 이 파일을 다음 위치에 배치합니다./etc/pki/libvirt/private/serverkey.pemservercert.pem- 서버의 인증서입니다. 서버의 다음 위치에 설치합니다./etc/pki/libvirt/servercert.pem

절차 5.3. 클라이언트 인증서 발급

- 모든 클라이언트(예: virt-manager와 같은 libvirt에 연결된 모든 프로그램)의 경우 X.509 Distinguished Name(DN)을 적절한 이름으로 설정해야 합니다. 이는 기업 차원에서 결정해야 합니다.예를 들어 다음 정보가 사용됩니다.

C=USA,ST=North Carolina,L=Raleigh,O=Red Hat,CN=name_of_client

C=USA,ST=North Carolina,L=Raleigh,O=Red Hat,CN=name_of_clientCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 프로세스는 절차 5.2. “서버 인증서 발급” 와 매우 유사하지만 다음과 같은 예외가 명시되어 있습니다. - 다음 명령을 사용하여 개인 키를 만듭니다.

certtool --generate-privkey > clientkey.pem

# certtool --generate-privkey > clientkey.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 먼저

client.info.info라는 템플릿 파일을 생성하여 CA의 개인 키 서명을 생성합니다. 파일에는 다음 내용이 포함되어야 합니다(지역/위치를 반영하도록 필드를 사용자 지정해야 함).Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 다음 명령을 사용하여 인증서에 서명합니다.

certtool --generate-certificate --load-privkey clientkey.pem --load-ca-certificate cacert.pem \ --load-ca-privkey cakey.pem --template client.info --outfile clientcert.pem

# certtool --generate-certificate --load-privkey clientkey.pem --load-ca-certificate cacert.pem \ --load-ca-privkey cakey.pem --template client.info --outfile clientcert.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 클라이언트 머신에 인증서를 설치합니다.

cp clientkey.pem /etc/pki/libvirt/private/clientkey.pem cp clientcert.pem /etc/pki/libvirt/clientcert.pem

# cp clientkey.pem /etc/pki/libvirt/private/clientkey.pem # cp clientcert.pem /etc/pki/libvirt/clientcert.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3. 전송 모드

TLS(Transport Layer Security)

SSL 3.1(Transport Layer Security TLS 1.0)이 인증되고 암호화된 TCP/IP 소켓은 일반적으로 공용 포트 번호에서 수신 대기합니다. 이를 사용하려면 클라이언트 및 서버 인증서를 생성해야 합니다. 표준 포트는 16514입니다.

UNIX 소켓

UNIX 도메인 소켓은 로컬 시스템에서만 액세스할 수 있습니다. 소켓은 암호화되지 않으며 인증을 위해 UNIX 권한 또는 SELinux를 사용합니다. 표준 소켓 이름은 /var/run/libvirt/libvirt-sock 및 /var/run/libvirt/libvirt-sock-ro 입니다(읽기 전용 연결의 경우).

SSH

SSH(Secure Shell 프로토콜) 연결을 통해 전송. Netcat( nc 패키지)이 설치되어 있어야 합니다. libvirt 데몬(libvirtd)이 원격 시스템에서 실행되고 있어야 합니다. SSH 액세스를 위해 포트 22를 열어야 합니다. 일종의 SSH 키 관리(예: ssh-agent 유틸리티)를 사용해야 합니다. 그렇지 않으면 암호를 입력하라는 메시지가 표시됩니다.

ext

ext 매개 변수는 libvirt 범위를 벗어나는 방법으로 원격 시스템에 연결할 수 있는 모든 외부 프로그램에 사용됩니다. 이 매개변수는 지원되지 않습니다.

TCP

암호화되지 않은 TCP/IP 소켓. 프로덕션 용도는 권장되지 않지만 일반적으로 비활성화되어 있지만 신뢰할 수 있는 네트워크를 통해 테스트하거나 사용할 수 있습니다. 기본 포트는 16509입니다.

원격 URI

URI(Uniform Resource Identifier)는 virsh 및 libvirt 에서 원격 호스트에 연결하는 데 사용됩니다. URI를 virsh 명령의 --connect 매개 변수와 함께 사용하여 원격 호스트에서 단일 명령 또는 마이그레이션을 실행할 수도 있습니다. 원격 URI는 일반 로컬 URI를 사용하고 호스트 이름 또는 전송 이름을 추가하여 구성됩니다. 'remote'의 URI 체계를 사용하는 특수한 경우 는 원격 libvirtd 서버에 최적의 하이퍼바이저 드라이버를 검색하도록 지시합니다. 로컬 연결에 대해 NULL URI를 전달하는 것과 같습니다.

driver[+transport]://[username@][hostname][:port]/path[?extraparameters]

driver[+transport]://[username@][hostname][:port]/path[?extraparameters]- qemu://hostname/

- xen://hostname/

- xen+ssh://hostname/

원격 관리 매개변수의 예

- SSH 전송 및 SSH 사용자 이름

virtuser를 사용하여host2라는 원격 KVM 호스트에 연결합니다. 각각에 대한 연결 명령은 [< name>] [-readonly] 입니다. 여기서 < name >은 여기에 설명된 대로 유효한 URI입니다. virsh connect 명령에 대한 자세한 내용은 다음을 참조하십시오. 14.1.5절. “연결”qemu+ssh://virtuser@hot2/

qemu+ssh://virtuser@hot2/Copy to Clipboard Copied! Toggle word wrap Toggle overflow - TLS를 사용하여

host2라는 호스트의 원격 KVM 하이퍼바이저에 연결합니다.qemu://host2/

qemu://host2/Copy to Clipboard Copied! Toggle word wrap Toggle overflow

테스트 예

- 비표준 UNIX 소켓을 사용하여 로컬 KVM 하이퍼바이저에 연결합니다. 이 경우 UNIX 소켓의 전체 경로는 명시적으로 제공됩니다.

qemu+unix:///system?socket=/opt/libvirt/run/libvirt/libvirt-sock

qemu+unix:///system?socket=/opt/libvirt/run/libvirt/libvirt-sockCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 포트 5000에서 IP 주소가 10.1.1.10인 서버에 암호화되지 않은 TCP/IP 연결을 사용하여 libvirt 데몬에 연결합니다. 기본 설정으로 테스트 드라이버를 사용합니다.

test+tcp://10.1.1.10:5000/default

test+tcp://10.1.1.10:5000/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow

추가 URI 매개변수

추가 매개 변수를 원격 URI에 추가할 수 있습니다. 표 5.1. “추가 URI 매개변수” 아래 표는 인식된 매개변수를 다룹니다. 다른 모든 매개변수는 무시됩니다. 매개 변수 값은 URI로 이스케이프되어야 합니다(즉, 매개 변수 및 특수 문자가 URI 형식으로 변환되기 전에 물음표(?)를 추가합니다.

| 이름 | 전송 모드 | 설명 | 사용 예 |

|---|---|---|---|

| name | 모든 모드 | 이름이 원격 virConnectOpen 기능에 전달되었습니다. 이름은 일반적으로 원격 URI에서 전송, 호스트 이름, 포트 번호, 사용자 이름 및 추가 매개 변수를 제거하여 구성되지만, 매우 복잡한 경우 이름을 명시적으로 제공하는 것이 더 좋습니다. | name=qemu:///system |

| command | SSH 및 ext | 외부 명령 ext 전송에는 이 작업이 필요합니다. ssh의 경우 기본값은 ssh입니다. PATH가 명령에 대해 검색됩니다. | command=/opt/openssh/bin/ssh |

| socket | Unix 및 ssh | 기본값을 재정의하는 UNIX 도메인 소켓의 경로입니다. ssh 전송의 경우 원격 netcat 명령에 전달됩니다(넷cat 참조). | socket=/opt/libvirt/run/libvirt/libvirt-sock |

| netcat | ssh |

netcat 명령을 사용하여 원격 시스템에 연결할 수 있습니다. 기본 netcat 매개변수는 nc 명령을 사용합니다. SSH 전송의 경우 libvirt는 아래 양식을 사용하여 SSH 명령을 구성합니다.

command -p port [-l username] hostname

Netcat -U socket

포트,username 및 hostname 매개 변수는 원격 URI의 일부로 지정할 수 있습니다. 명령,netcat 및 socket 은 다른 추가 매개 변수에서 제공됩니다.

| netcat=/opt/netcat/bin/nc |

| no_verify | tls | 0이 아닌 값으로 설정하면 클라이언트 인증서가 비활성화됩니다. 클라이언트의 인증서 또는 IP 주소를 서버 확인을 비활성화하려면 libvirtd 구성을 변경해야 합니다. | no_verify=1 |

| no_tty | ssh | 0이 아닌 값으로 설정하면 원격 머신에 자동으로 로그인할 수 없는 경우 암호를 요청하는 ssh가 중지됩니다. . 터미널 에 액세스할 수 없는 경우 이 값을 사용합니다. | no_tty=1 |

6장. KVM으로 과다 할당

6.1. 메모리 과다 할당

6.2. 가상화된 CPU 오버 커밋

7장. KSM

qemu-kvm 프로세스의 메모리만 상속합니다. 게스트 가상 머신이 실행되면 게스트가 동일한 운영 체제 또는 애플리케이션을 실행할 때 게스트 가상 머신 운영 체제 이미지의 콘텐츠를 공유할 수 있습니다.

/sys/kernel/mm/ksm/merge_across_nodes 튜닝 가능 항목을 0 으로 변경합니다. 커널 메모리 회계 통계는 대량의 교차 노드 병합 후 결국 서로 모순될 수 있습니다. 따라서 KSM 데몬에서 대량의 메모리를 병합한 후 numad가 혼동될 수 있습니다. 시스템에 사용 가능한 메모리가 많은 경우 KSM 데몬을 끄고 비활성화하여 더 높은 성능을 얻을 수 있습니다. NUMA에 대한 자세한 내용은 Red Hat Enterprise Linux 성능 튜닝 가이드 를 참조하십시오.

ksm서비스는 KSM 커널 스레드를 시작하고 중지합니다.ksmtuned서비스는 동일한 페이지 병합을 동적으로 관리하면서ksm을 제어하고 조정합니다.ksmtuned서비스는ksm을 시작하고 메모리 공유가 필요하지 않은 경우ksm서비스를 중지합니다.ksmtuned서비스에 새 게스트가 생성 또는 삭제될 때 실행할retune매개변수가 있어야 합니다.

KSM 서비스

ksm 서비스는 qemu-kvm 패키지에 포함되어 있습니다. KSM은 Red Hat Enterprise Linux 6에서 기본적으로 꺼져 있습니다. 그러나 Red Hat Enterprise Linux 6를 KVM 호스트 물리적 시스템으로 사용하는 경우 ksm/ksmtuned 서비스를 통해 켜질 수 있습니다.

ksm 서비스가 시작되지 않으면 KSM은 2000 페이지만 공유합니다. 이 기본값은 낮으며 제한된 메모리 저장 이점을 제공합니다.

ksm 서비스가 시작되면 KSM은 호스트 물리적 시스템 기본 메모리의 절반까지 공유합니다. KSM이 더 많은 메모리를 공유할 수 있도록 ksm 서비스를 시작합니다.

service ksm start Starting ksm: [ OK ]

# service ksm start

Starting ksm: [ OK ]ksm 서비스는 기본 시작 시퀀스에 추가할 수 있습니다. chkconfig 명령을 사용하여 ksm 서비스를 영구적으로 만듭니다.

chkconfig ksm on

# chkconfig ksm onKSM Tuning Service

ksmtuned 서비스에는 옵션이 없습니다. ksmtuned 서비스 루프는 ksm 을 조정합니다. 게스트 가상 머신을 만들거나 삭제할 때 ksmtuned 서비스는 libvirt에서 알림을 받습니다.

service ksmtuned start Starting ksmtuned: [ OK ]

# service ksmtuned start

Starting ksmtuned: [ OK ]retune 매개변수를 사용하여 ksmtuned 서비스를 조정할 수 있습니다. retune 매개변수는 ksmtuned 에 튜닝 기능을 수동으로 실행하도록 지시합니다.

제한- 활성화 임계값(KB)입니다. 모든qemu-kvm프로세스의 합계에 추가된 증가 값이 총 시스템 메모리를 초과하는 경우 KSM 주기가 트리거됩니다.이 매개변수는KSM_THRES_COEF에 정의된 백분율의 kbytes와 동일합니다.

/etc/ksmtuned.conf 파일은 ksmtuned 서비스의 구성 파일입니다. 아래의 파일 출력은 기본 ksmtuned.conf 파일입니다.

KSM 변수 및 모니터링

KSM은 모니터링 데이터를 /sys/kernel/mm/ksm/ 디렉토리에 저장합니다. 이 디렉터리의 파일은 커널에 의해 업데이트되며 KSM 사용량 및 통계에 대한 정확한 기록입니다.

/etc/ksmtuned.conf 파일의 설정 가능한 변수이기도 합니다.

/sys/kernel/mm/ksm/ 파일

- full_scans

- 전체 검사 실행.

- pages_shared

- 총 페이지 공유.

- pages_sharing

- 현재 공유된 페이지입니다.

- pages_to_scan

- 페이지를 스캔하지 않습니다.

- pages_unshared

- 페이지가 더 이상 공유되지 않습니다.

- pages_volatile

- 휘발성 페이지 수입니다.

- run

- KSM 프로세스가 실행 중인지 여부

- sleep_millisecs

- 수면 밀리초입니다.

DEBUG=1 행이 /etc/ksmtuned.conf 파일에 추가되는 경우 KSM 튜닝 활동은 /var/log/ksmtuned 로그 파일에 저장됩니다. 로그 파일 위치는 LOGFILE 매개 변수를 사용하여 변경할 수 있습니다. 로그 파일 위치 변경은 권장되지 않으며 SELinux 설정을 특별한 설정이 필요할 수 있습니다.

KSM 비활성화

KSM에는 특정 환경 또는 물리적 머신 시스템에 비해 너무 커질 수 있는 성능 오버헤드가 있습니다.

ksmtuned 및 ksm 서비스를 중지하여 비활성화할 수 있습니다. 서비스를 중지하면 KSM이 비활성화되지만 다시 시작한 후에는 유지되지 않습니다.

chkconfig ksm off chkconfig ksmtuned off

# chkconfig ksm off

# chkconfig ksmtuned off8장. 고급 게스트 가상 시스템 관리

8.1. 제어 그룹(cgroups)

8.2. 대규모 페이지 지원

소개

x86 CPU는 일반적으로 4kB 페이지의 메모리를 처리하지만 대규모 페이지라는 더 큰 페이지를 사용할 수 있습니다. TLB(Transaction Lookaside Buffer) 에 대해 CPU 캐시 적중을 늘려 성능을 개선하기 위해 KVM 게스트를 대규모 페이지 메모리 지원과 함께 배포할 수 있습니다. 대규모 페이지는 특히 대규모 메모리 및 메모리 집약적 워크로드의 경우 성능을 크게 향상시킬 수 있습니다. Red Hat Enterprise Linux 6은 대규모 페이지 사용을 통해 페이지 크기를 늘려 많은 양의 메모리를 보다 효과적으로 관리할 수 있습니다.

투명한 대규모 페이지

THP( 투명한 대규모 페이지 )는 애플리케이션에 필요한 TLB 항목을 줄이는 커널 기능입니다. 모든 여유 메모리를 캐시로 사용할 수도 있으므로 성능이 향상됩니다.

qemu.conf 파일의 특별한 구성이 필요하지 않습니다. 대규모 페이지는 /sys/kernel/mm/redhat_transparent_hugepage/enabled 가 항상 로 설정된 경우 기본적으로 사용됩니다.

hugetlbfs 기능을 사용하지 않습니다. 그러나 hugetlbfs를 사용하지 않는 경우 KVM은 일반 4kB 페이지 크기 대신 투명한 대규모 페이지를 사용합니다.

8.3. Hyper-V Hypervisor에서 Red Hat Enterprise Linux를 게스트 가상 머신으로 실행

- 업그레이드된 VMBUS 프로토콜 - VMBUS 프로토콜이 Windows 8 수준으로 업그레이드되었습니다. 이 작업의 일환으로 이제 게스트에서 사용 가능한 모든 가상 CPU에서 VMBUS 인터럽트를 처리할 수 있습니다. 또한 Red Hat Enterprise Linux 게스트 가상 머신과 Windows 호스트 물리적 머신 간의 신호 지정 프로토콜이 최적화되었습니다.

- 합성 프레임 버퍼 드라이버 - Red Hat Enterprise Linux 데스크탑 사용자를 위해 향상된 그래픽 성능과 뛰어난 해상도를 제공합니다.

- 실시간 가상 머신 백업 지원 - 라이브 Red Hat Enterprise Linux 게스트 가상 머신에 대한 중단없는 백업 지원

- 고정된 크기의 Linux VHD를 동적 확장 - 라이브 마운트 크기 Red Hat Enterprise Linux VHDs를 확장할 수 있습니다.

8.4. 게스트 가상 머신 메모리 할당

바이트의b또는 바이트KBfor kilobytes (10 또는 1,000 바이트 블록)kibibytes의 경우 kibibytes 1024바이트의 K 또는KiBMBfor megabytes (106 또는 1,000,000 바이트 블록)- 메비바이트의 경우 m 또는

MiB(20 또는 blocks 1,048,576 바이트) GBfor gigabytes (109 또는 1,000,000,000 바이트 블록)- 기비바이트의 경우

G또는GiB(230 또는 1,073,741,824 바이트) TBfor terabytes (1012 또는 1,000,000 바이트 블록)- tebibytes의 경우 t or

TiB(240 또는 1,099,511,627,776 바이트)

메모리 단위 에 따라 결정됩니다. 기본값은 kibibytes(KiB) 단위로 지정된 값이 1024바이트의 2개 또는 블록으로 곱한 단위입니다.

dumpCore 를 사용하여 게스트 가상 머신의 메모리를 생성된 코어dump(dumpCore='on')에 포함해야 하는지 여부를 제어하는 데 사용할 수 있습니다(dumpCore='off'). 기본 설정은 에 있으므로 매개변수가 off 로 설정되지 않은 경우 게스트 가상 머신 메모리가 coredump 파일에 포함됩니다.

currentMemory 속성은 게스트 가상 머신에 대한 실제 메모리 할당을 결정합니다. 이 값은 최대 할당보다 작을 수 있으며, 이를 통해 게스트 가상 머신 메모리를 즉시 늘릴 수 있습니다. 이 값을 생략하면 기본값은 memory 요소와 동일한 값입니다. unit 속성은 메모리와 동일하게 작동합니다.

8.5. 게스트 가상 머신 자동 시작

TestServer 를 설정하여 호스트 물리적 시스템이 부팅될 때 자동으로 시작됩니다.

virsh autostart TestServer Domain TestServer marked as autostarted

# virsh autostart TestServer

Domain TestServer marked as autostarted

--disable 매개 변수를 사용합니다.

virsh autostart --disable TestServer Domain TestServer unmarked as autostarted

# virsh autostart --disable TestServer

Domain TestServer unmarked as autostarted

8.6. 게스트 가상 머신에 대한 SMART 디스크 모니터링 비활성화

service smartd stop chkconfig --del smartd

# service smartd stop

# chkconfig --del smartd

8.7. VNC 서버 구성

~/.vnc/xstartup 파일을 만든 다음 편집하여 vncserver 가 시작될 때마다 GNOME 세션을 시작합니다. vncserver 스크립트를 처음 실행하는 경우 VNC 세션에 사용하려는 암호를 요청합니다. vnc 서버 파일에 대한 자세한 내용은 Red Hat Enterprise Linux 설치 가이드 를 참조하십시오.

8.8. 새로운 고유 MAC 주소 생성

macgen.py 로 저장합니다. 이제 해당 디렉토리에서 ./macgen.py 를 사용하여 스크립트를 실행할 수 있으며 새 MAC 주소를 생성합니다. 샘플 출력은 다음과 같습니다.

./macgen.py 00:16:3e:20:b0:11

$ ./macgen.py

00:16:3e:20:b0:118.8.1. 게스트 가상 머신용 새 MAC을 생성하는 또 다른 방법

echo 'import virtinst.util ; print\ virtinst.util.uuidToString(virtinst.util.randomUUID())' | python echo 'import virtinst.util ; print virtinst.util.randomMAC()' | python

# echo 'import virtinst.util ; print\

virtinst.util.uuidToString(virtinst.util.randomUUID())' | python

# echo 'import virtinst.util ; print virtinst.util.randomMAC()' | python

8.9. 게스트 가상 머신 응답 시간 개선

- 메모리 과다 할당.

- 프로세서 사용량이 높은 오버 커밋된 메모리

- 다른 ( qemu-kvm 프로세스가 아님) 호스트 물리적 시스템에서 프로세스를 사용 중이거나 정지했습니다.

8.10. libvirt를 사용한 가상 머신 타이머 관리

<clock> 요소는 게스트 가상 시스템 시계가 호스트 물리적 시스템 클럭과 어떻게 동기화되는지 결정하는 데 사용됩니다. clock 요소에는 다음과 같은 속성이 있습니다.

오프셋은 게스트 가상 머신 클럭이 호스트 실제 머신 클럭에서 오프셋되는 방식을 결정합니다. offset 속성에는 다음과 같은 가능한 값이 있습니다.Expand 표 8.1. 특성 값 오프셋 값 설명 utc 부팅 시 게스트 가상 머신 클럭이 UTC에 동기화됩니다. 현지 시간 게스트 가상 머신 클럭은 부팅될 때 호스트 물리적 시스템의 구성된 시간대(있는 경우)에 동기화됩니다. timezone 게스트 가상 머신 클럭은 timezone특성으로 지정된 지정된 시간대에 동기화됩니다.변수 게스트 가상 머신 클럭은 UTC의 임의의 오프셋에 동기화됩니다. UTC를 기준으로 하는 delta는 조정특성을 사용하여 초 단위로 지정됩니다. 게스트 가상 머신은 시간 경과에 따라 RTC(Real Time Clock)를 자유롭게 조정할 수 있으며 다음 재부팅 시에도 적용됩니다. 이는utc모드와 달리, 각 재부팅 시 RTC 조정이 손실됩니다.참고값 utc 는 기본적으로 가상 머신에서 클럭 오프셋으로 설정됩니다. 그러나 게스트 가상 머신 클럭이 localtime 값으로 실행되는 경우 게스트 가상 머신 클럭을 호스트 물리적 시스템 클럭과 동기화하려면 클럭 오프셋을 다른 값으로 변경해야 합니다.timezone속성은 게스트 가상 시스템 클럭에 사용되는 시간대를 결정합니다.조정속성은 게스트 가상 머신 클럭 동기화를 위해 delta를 제공합니다. UTC를 기준으로 하는 시간(초)입니다.

예 8.1. 항상 UTC와 동기화

<clock offset="utc" />

<clock offset="utc" />예 8.2. 항상 호스트 실제 시스템 시간대와 동기화

<clock offset="localtime" />

<clock offset="localtime" />예 8.3. 임의의 시간대에 동기화

<clock offset="timezone" timezone="Europe/Paris" />

<clock offset="timezone" timezone="Europe/Paris" />예 8.4. UTC + 임의의 오프셋과 동기화

<clock offset="variable" adjustment="123456" />

<clock offset="variable" adjustment="123456" />8.10.1. 클럭을 위한 타이머 하위 요소

이름만 필요하며 다른 모든 속성은 선택 사항입니다.

name 속성은 사용할 시간 소스의 유형을 지시하며 다음 중 하나일 수 있습니다.

| 값 | 설명 |

|---|---|

| pit | Custom Interval timer - 주기적인 인터럽트가 있는 타이머입니다. |

| rtc | 실시간 시계 - 주기적인 인터럽트를 사용하여 지속적으로 실행되는 타이머입니다. |

| tsc | Time Stamp counter - 재설정 이후의 틱 수를 계산하고, 인터럽트가 없습니다. |

| kvmclock | KVM 클럭 - KVM 게스트 가상 머신에 권장되는 클럭 소스입니다. KVM pvclock 또는 kvm-clock을 사용하면 게스트 가상 머신이 호스트 물리적 시스템의 월 시계 시간을 읽을 수 있습니다. |

8.10.2. track

track 속성은 타이머를 통해 추적되는 항목을 지정합니다. 이름 값 rtc 에만 유효합니다.

| 값 | 설명 |

|---|---|

| boot | 이전 호스트 물리적 머신 옵션에 해당하며 지원되지 않는 추적 옵션입니다. |

| 게스트 | RTC는 항상 게스트 가상 머신 시간을 추적합니다. |

| wall | RTC는 항상 호스트 시간을 추적합니다. |

8.10.3. tickpolicy

tickpolicy 특성은 게스트 가상 머신에 눈금을 전달하는 데 사용되는 정책을 할당합니다. 다음 값이 허용됩니다.

| 값 | 설명 |

|---|---|

| delay | 계속 정상적으로 전달하십시오(추적이 지연됨). |

| catchup | 더 높은 비율로 가져와 차지할 수 있습니다. |

| 병합 | 하나의 진드기는 하나의 진드로 병합되었습니다. |

| 삭제 | 누락된 모든 틱은 모두 삭제됩니다. |

8.10.4. 빈도, 모드 및 현재

빈도 속성은 고정 빈도를 설정하는 데 사용되며 Hz로 측정됩니다. 이 속성은 name 요소에 tsc 값이 있는 경우에만 관련이 있습니다. 다른 모든 타이머는 고정 빈도(pit,rtc) 에서 작동합니다.

mode 는 시간 소스가 게스트 가상 머신에 노출되는 방식을 결정합니다. 이 속성은 이름 값 tsc 와만 관련이 있습니다. 다른 모든 타이머는 항상 에뮬레이션됩니다. 명령은 < timer name='tsc' frequency='NNN' mode='auto|native|emulate|smpsafe'/ > 와 같습니다. 모드 정의는 표에 제공됩니다.

| 값 | 설명 |

|---|---|

| auto | TSC가 불안정한 경우 네이티브 TSC 액세스를 허용하십시오. |

| 실제 하드웨어에 적용 | 항상 네이티브 TSC 액세스를 허용합니다. |

| 에뮬레이션 | 항상 에뮬레이트해야 합니다. |

| smpsafe | 항상 에뮬레이션 TSC 및 상호 잠금 가속화 |

present 는 게스트 가상 머신에 표시되는 기본 타이머 세트를 재정의하는 데 사용됩니다.

| 값 | 설명 |

|---|---|

| 제공됨 | 게스트 가상 머신에 표시되는 이 타이머를 강제 적용합니다. |

| 제공되지 않음 | 게스트 가상 머신에 이 타이머를 강제로 표시하지 않도록 합니다. |

8.10.5. Clock Synchronization 사용 예

예 8.5. RTC 및 PIT 타이머를 사용하여 로컬 시간에 클럭 동기화

<clock offset="localtime"> <timer name="rtc" tickpolicy="catchup" track="guest virtual machine" /> <timer name="pit" tickpolicy="delay" /> </clock>

<clock offset="localtime">

<timer name="rtc" tickpolicy="catchup" track="guest virtual machine" />

<timer name="pit" tickpolicy="delay" />

</clock>- 게스트 가상 머신에는 CPU가 하나만 있을 수 있습니다.

- APIC 타이머를 비활성화해야 합니다 (noapictimer" 명령줄 옵션 사용)

- NoHZ 모드는 게스트에서 비활성화해야 합니다 (nohz=off" 명령줄 옵션 사용)

- 높은 해상도 타이머 모드를 게스트에서 비활성화해야 합니다 ('highres=off" 명령줄 옵션 사용)

- PIT 클럭 소스는 높은 해상도의 타이머 모드 또는 NoHz 모드와 호환되지 않습니다.

8.11. PMU를 사용하여 게스트 가상 머신 성능 모니터링

yum install perf.

# yum install perf.8.12. 게스트 가상 머신 전원 관리

pm 은 S3(suspend-to-disk) 및 S4(suspend-to-mem) ACPI sleep 상태에 대한 BIOS 지원을 비활성화('yes') 또는 비활성화합니다. 아무것도 지정하지 않으면 하이퍼바이저는 기본값으로 유지됩니다.

9장. 게스트 가상 머신 장치 구성

- 에뮬레이션된 장치는 실제 하드웨어를 모방하는 순수한 가상 장치이므로 수정되지 않은 게스트 운영 체제가 표준 인 박스 드라이버를 사용하여 작업할 수 있습니다. Red Hat Enterprise Linux 6는 최대 216 virtio 장치를 지원합니다.

- virtio 장치는 가상 머신에서 최적으로 작동하도록 설계된 순전히 가상 장치입니다. virtio 장치는 에뮬레이션된 장치와 유사하지만 Linux 이외의 가상 시스템에는 기본적으로 필요한 드라이버가 포함되어 있지 않습니다. Virtual Machine Manager(virt-manager) 및 RHV-H(Red Hat Virtualization Hypervisor)와 같은 가상화 관리 소프트웨어는 지원되는 비 Linux 게스트 운영 체제에 이러한 드라이버를 자동으로 설치합니다. Red Hat Enterprise Linux 6는 최대700개의scsi 디스크를 지원합니다.

- 할당된 장치는 가상 머신에 노출되는 물리적 장치입니다. 이 방법은 'passthrough'라고도 합니다. 장치 할당을 통해 가상 머신은 다양한 작업을 위해 PCI 장치에 독점적으로 액세스할 수 있으며 PCI 장치는 게스트 운영 체제에 물리적으로 연결된 것처럼 표시 및 작동할 수 있습니다. Red Hat Enterprise Linux 6는 가상 머신당 최대 32개의 할당된 장치를 지원합니다.

/etc/libvirt/qemu.conf에서 재정의할 수 있는 /etc/security/limits.conf 에서 구성됨). 다른 제한 요소에는 가상 버스에서 사용할 수 있는 슬롯 수와 sysctl이 설정한 오픈 파일에 대한 시스템 전체 제한이 포함됩니다.

vfio_iommu_type1 모듈에 allow_unsafe_interrupts 옵션을 사용하여 PCI 장치 할당을 허용하도록 선택할 수 있습니다. 이 작업은 다음을 포함하는 /etc/modprobe.d 에 .conf 파일(예: local.conf)을 추가하여 영구적으로 수행할 수 있습니다.

options vfio_iommu_type1 allow_unsafe_interrupts=1

options vfio_iommu_type1 allow_unsafe_interrupts=1echo 1 > /sys/module/vfio_iommu_type1/parameters/allow_unsafe_interrupts

# echo 1 > /sys/module/vfio_iommu_type1/parameters/allow_unsafe_interrupts9.1. PCI 장치

절차 9.1. PCI 장치 할당을 위한 Intel 시스템 준비

Intel VT-d 사양 활성화

Intel VT-d 사양에서는 가상 머신에 물리적 장치를 직접 할당하는 하드웨어 지원을 제공합니다. 이러한 사양은 Red Hat Enterprise Linux에서 PCI 장치 할당을 사용하는 데 필요합니다.BIOS에서 Intel VT-d 사양을 활성화해야 합니다. 일부 시스템 제조업체에서는 기본적으로 이러한 사양을 사용하지 않도록 설정되어 있습니다. 이러한 사양을 참조하는 데 사용되는 조건은 제조업체마다 다를 수 있습니다. 적절한 약관에 대해서는 시스템 제조업체 설명서를 참조하십시오.커널에서 Intel VT-d 활성화

/etc/sysconfig/grub파일에 있는 GRUB_CMDLINX_LINUX 행 끝에intel_iommu=on매개 변수를 추가하여 커널에서 Intel VT-d를 활성화합니다.아래 예제는 Intel VT-d가 활성화된 수정된grub파일입니다.GRUB_CMDLINE_LINUX="rd.lvm.lv=vg_VolGroup00/LogVol01 vconsole.font=latarcyrheb-sun16 rd.lvm.lv=vg_VolGroup_1/root vconsole.keymap=us $([ -x /usr/sbin/rhcrashkernel-param ] && /usr/sbin/ rhcrashkernel-param || :) rhgb quiet intel_iommu=on"

GRUB_CMDLINE_LINUX="rd.lvm.lv=vg_VolGroup00/LogVol01 vconsole.font=latarcyrheb-sun16 rd.lvm.lv=vg_VolGroup_1/root vconsole.keymap=us $([ -x /usr/sbin/rhcrashkernel-param ] && /usr/sbin/ rhcrashkernel-param || :) rhgb quiet intel_iommu=on"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 구성 파일 다시 생성

다음을 실행하여 /etc/grub2.cfg를 다시 생성합니다.grub2-mkconfig -o /etc/grub2.cfg

grub2-mkconfig -o /etc/grub2.cfgCopy to Clipboard Copied! Toggle word wrap Toggle overflow UEFI 기반 호스트를 사용하는 경우 대상 파일은/etc/grub2-efi.cfg여야 합니다.사용할 준비가

시스템을 재부팅하여 변경 사항을 활성화합니다. 이제 시스템이 PCI 장치 할당을 수행할 수 있습니다.

절차 9.2. PCI 장치 할당을 위한 AMD 시스템 준비

AMD IOMMU 사양 활성화

Red Hat Enterprise Linux에서 PCI 장치 할당을 사용하려면 AMD IOMMU 사양이 필요합니다. BIOS에서 이러한 사양을 활성화해야 합니다. 일부 시스템 제조업체에서는 기본적으로 이러한 사양을 사용하지 않도록 설정되어 있습니다.IOMMU 커널 지원 활성화

/etc/sysconfig/grub에 있는 GRUB_CMDLINX_LINUX 행의 끝에amd_iommu=on을 추가하여 부팅 시 AMD IOMMU 사양을 활성화합니다.구성 파일 다시 생성

다음을 실행하여 /etc/grub2.cfg를 다시 생성합니다.grub2-mkconfig -o /etc/grub2.cfg

grub2-mkconfig -o /etc/grub2.cfgCopy to Clipboard Copied! Toggle word wrap Toggle overflow UEFI 기반 호스트를 사용하는 경우 대상 파일은/etc/grub2-efi.cfg여야 합니다.사용할 준비가

시스템을 재부팅하여 변경 사항을 활성화합니다. 이제 시스템이 PCI 장치 할당을 수행할 수 있습니다.

9.1.1. virsh를 사용하여 PCI 장치 할당

pci_0000_01_00_0 과 함께 PCIe 네트워크 컨트롤러를 사용하고 guest1-rhel6-64 라는 완전히 가상화된 게스트 시스템을 사용합니다.

절차 9.3. virsh를 사용하여 게스트 가상 머신에 PCI 장치 할당

장치 확인

먼저 가상 머신에 장치 할당을 위해 지정된 PCI 장치를 식별합니다. lspci 명령을 사용하여 사용 가능한 PCI 장치를 나열합니다. grep 을 사용하여 lspci 의 출력을 구체화할 수 있습니다.이 예에서는 다음 출력에서 강조 표시된 이더넷 컨트롤러를 사용합니다.lspci | grep Ethernet 00:19.0 Ethernet controller: Intel Corporation 82567LM-2 Gigabit Network Connection 01:00.0 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01) 01:00.1 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01)

# lspci | grep Ethernet 00:19.0 Ethernet controller: Intel Corporation 82567LM-2 Gigabit Network Connection 01:00.0 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01) 01:00.1 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 이더넷 컨트롤러는 짧은 식별자00:19.0과 함께 표시됩니다. 이 PCI 장치를 가상 시스템에 할당하려면 virsh 에서 사용하는 전체 식별자를 찾아야 합니다.이를 위해 virsh nodedev-list 명령을 사용하여 호스트 시스템에 연결된 특정 유형(pci)의 모든 장치를 나열합니다. 그런 다음 사용하려는 장치의 짧은 식별자에 매핑되는 문자열의 출력을 확인합니다.이 예제에서는 짧은 식별자가00:19.0인 이더넷 컨트롤러에 매핑되는 문자열을 강조 표시합니다. 이 예제에서는:및.문자는 전체 식별자에서 밑줄로 교체됩니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 사용하려는 장치에 매핑되는 PCI 장치 번호를 기록합니다. 이는 다른 단계에서 필요합니다.장치 정보 검토

domain, bus 및 function에 대한 정보는 virsh nodedev-dumpxml 명령 출력에서 확인할 수 있습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고IOMMU 그룹은 IOMMU의 관점에서 장치의 가시성 및 분리에 따라 결정됩니다. 각 IOMMU 그룹은 하나 이상의 장치를 포함할 수 있습니다. 여러 장치가 있는 경우 IOMMU 그룹 내의 모든 엔드 포인트를 게스트에 할당하려면 그룹 내의 모든 장치에 대해 클레임해야 합니다. 이 작업은 게스트에 추가 엔드포인트를 할당하거나 virsh nodedev-detach 를 사용하여 호스트 드라이버에서 분리하여 수행할 수 있습니다. 단일 그룹 내에 포함된 장치는 여러 게스트 간에 분할하거나 호스트와 게스트 간에 분할할 수 없습니다. PCIe 루트 포트, 스위치 포트 및 브리지와 같은 비 엔드 포인트 장치는 호스트 드라이버에서 분리되지 않아야 하며 끝점 할당을 방해하지 않습니다.IOMMU 그룹 내의 장치는 virsh nodedev-dumpxml 출력의 iommuGroup 섹션을 사용하여 결정할 수 있습니다. 그룹의 각 멤버는 별도의 "address" 필드를 통해 제공됩니다. 이 정보는 다음을 사용하여 sysfs에서 찾을 수도 있습니다.출력 예는 다음과 같습니다.ls /sys/bus/pci/devices/0000:01:00.0/iommu_group/devices/

$ ls /sys/bus/pci/devices/0000:01:00.0/iommu_group/devices/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 그룹에 0000.01.00.0만 할당하려면 게스트를 시작하기 전에 사용하지 않은 끝점을 호스트에서 분리해야 합니다.0000:01:00.0 0000:01:00.1

0000:01:00.0 0000:01:00.1Copy to Clipboard Copied! Toggle word wrap Toggle overflow virsh nodedev-detach pci_0000_01_00_1

$ virsh nodedev-detach pci_0000_01_00_1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 필수 구성 세부 정보 확인

구성 파일에 필요한 값에 대해서는 virsh nodedev-dumpxml pci_0000_00_19_0 명령의 출력을 참조하십시오.예제 장치의 값은 bus = 0, slot = 25이고 function = 0입니다. 10진수 구성은 다음 세 가지 값을 사용합니다.bus='0' slot='25' function='0'

bus='0' slot='25' function='0'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 구성 세부 정보 추가

virsh edit 를 실행하여 가상 시스템 이름을 지정하고 <source> 섹션에 장치 항목을 추가하여 PCI 장치를 게스트 가상 머신에 할당합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 또는 virsh attach-device 를 실행하여 가상 시스템 이름과 게스트의 XML 파일을 지정합니다.virsh attach-device guest1-rhel6-64 file.xml

virsh attach-device guest1-rhel6-64 file.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 가상 머신 시작

virsh start guest1-rhel6-64

# virsh start guest1-rhel6-64Copy to Clipboard Copied! Toggle word wrap Toggle overflow

9.1.2. virt-manager를 사용하여 PCI 장치 할당

절차 9.4. virt-manager를 사용하여 게스트 가상 머신에 PCI 장치 할당

하드웨어 설정 열기

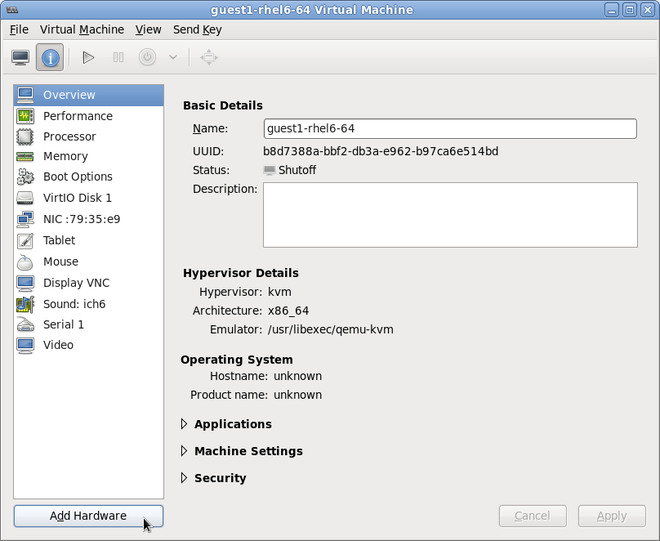

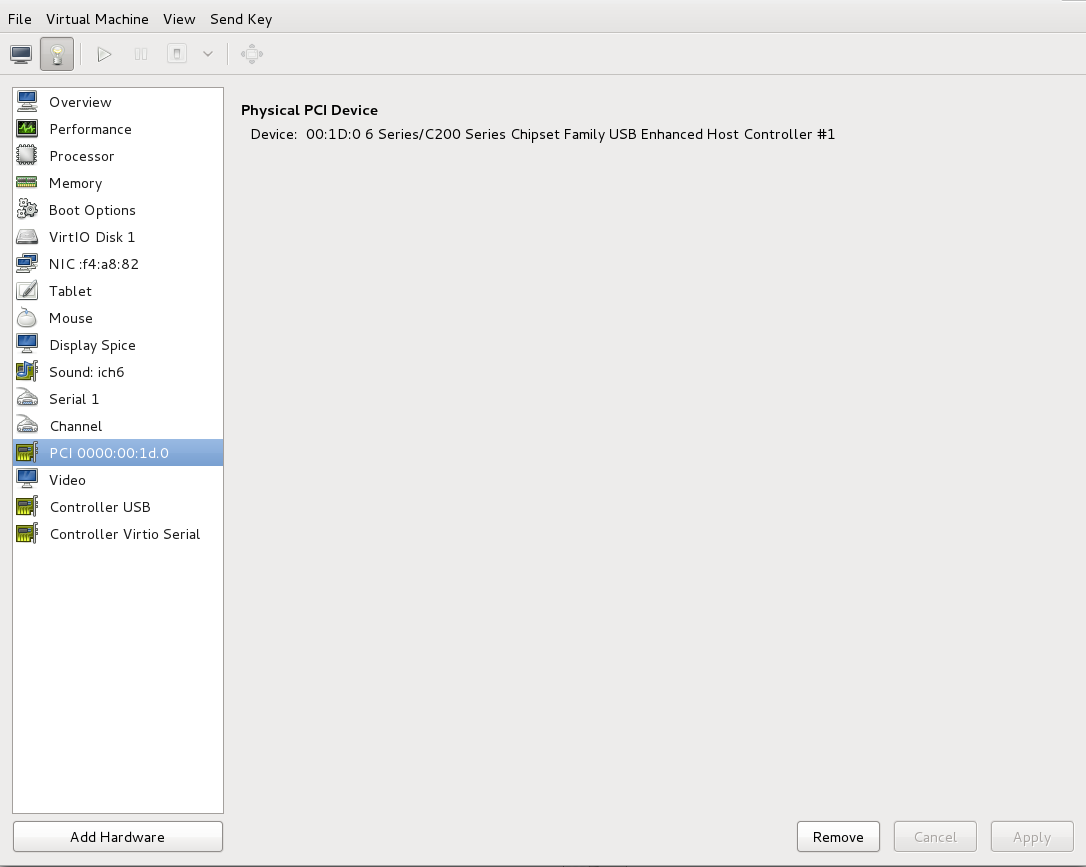

게스트 가상 머신을 열고 을 클릭하여 가상 머신에 새 장치를 추가합니다.그림 9.1. 가상 머신 하드웨어 정보 창

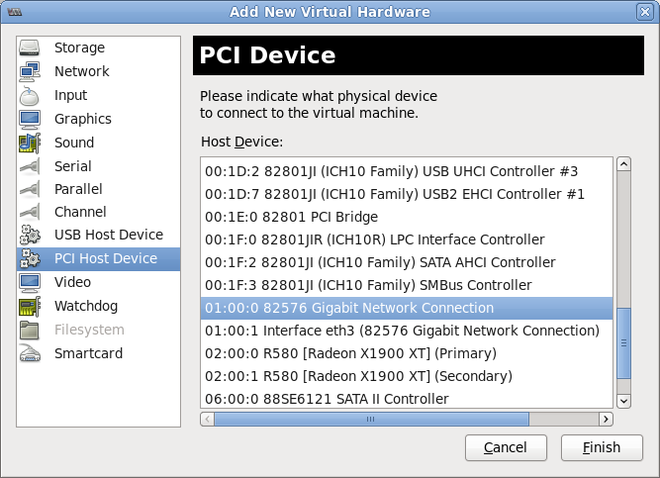

PCI 장치 선택

왼쪽의 하드웨어 목록에서 PCI Host Device 를 선택합니다.사용되지 않는 PCI 장치를 선택합니다. 다른 게스트에서 사용 중인 PCI 장치를 선택하면 오류가 발생할 수 있습니다. 이 예에서는 스페어 82576 네트워크 장치가 사용됩니다. 완료 를 클릭하여 설정을 완료합니다.그림 9.2. 가상 하드웨어 추가 마법사

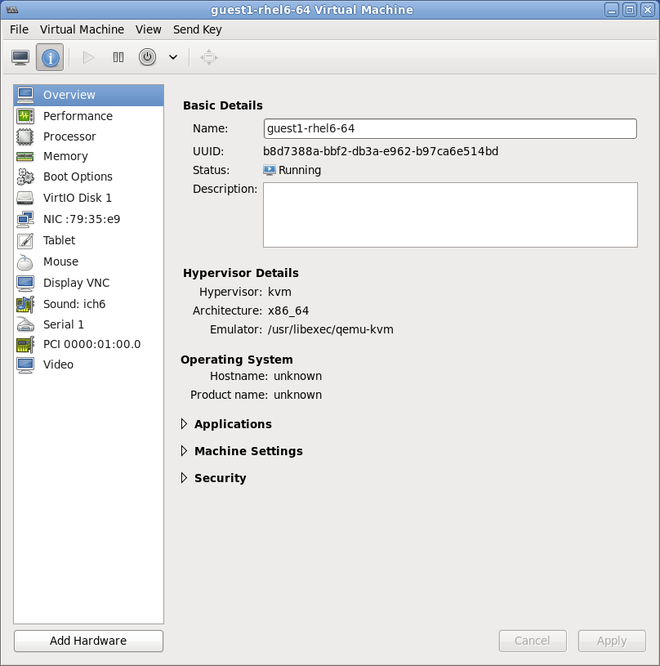

새 장치 추가

설정이 완료되었으며 게스트 가상 머신이 이제 PCI 장치에 직접 액세스할 수 있습니다.그림 9.3. 가상 머신 하드웨어 정보 창

9.1.3. virt-install을 사용한 PCI 장치 할당

--host-device 매개 변수를 사용합니다.

절차 9.5. virt-install을 사용하여 가상 머신에 PCI 장치 할당

장치 확인

게스트 가상 머신에 장치 할당을 위해 지정된 PCI 장치를 식별합니다.lspci | grep Ethernet 00:19.0 Ethernet controller: Intel Corporation 82567LM-2 Gigabit Network Connection 01:00.0 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01) 01:00.1 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01)

# lspci | grep Ethernet 00:19.0 Ethernet controller: Intel Corporation 82567LM-2 Gigabit Network Connection 01:00.0 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01) 01:00.1 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01)Copy to Clipboard Copied! Toggle word wrap Toggle overflow virsh nodedev-list 명령은 시스템에 연결된 모든 장치를 나열하고 각 PCI 장치를 문자열로 식별합니다. 출력을 PCI 장치로만 제한하려면 다음 명령을 실행합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow PCI 장치 번호를 기록합니다. 다른 단계에는 숫자가 필요합니다.도메인, 버스 및 기능에 대한 정보는 virsh nodedev-dumpxml 명령 출력에서 확인할 수 있습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고IOMMU 그룹에 여러 끝점이 있고 모든 엔드포인트가 게스트에 할당되지 않은 경우 게스트를 시작하기 전에 다음 명령을 실행하여 호스트에서 다른 끝점을 수동으로 분리해야 합니다.virsh nodedev-detach pci_0000_00_19_1

$ virsh nodedev-detach pci_0000_00_19_1Copy to Clipboard Copied! Toggle word wrap Toggle overflow IOMMU 그룹에 대한 자세한 내용은 참고 의 9.1.1절. “virsh를 사용하여 PCI 장치 할당” 를 참조하십시오.장치 추가

virsh nodedev 명령의 PCI 식별자 출력을--host-device매개 변수의 값으로 사용합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 설치 완료

게스트 설치를 완료합니다. PCI 장치를 게스트에 연결해야 합니다.

9.1.4. 할당된 PCI 장치 분리

절차 9.6. virsh를 사용하여 게스트에서 PCI 장치 분리

장치 분리

다음 명령을 사용하여 게스트의 XML 파일에서 PCI 장치를 제거하여 게스트에서 PCI 장치를 분리합니다.virsh detach-device name_of_guest file.xml

# virsh detach-device name_of_guest file.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 장치를 호스트에 다시 연결합니다(선택 사항)

장치가관리모드에 있는 경우 이 단계를 건너뜁니다. 장치가 자동으로 호스트로 반환됩니다.장치가관리모드를 사용하지 않는 경우 다음 명령을 사용하여 PCI 장치를 호스트 머신에 다시 연결합니다.virsh nodedev-reattach device

# virsh nodedev-reattach deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들어pci_0000_01_00_0장치를 호스트에 다시 연결하려면 다음을 수행합니다.virsh nodedev-reattach pci_0000_01_00_0

virsh nodedev-reattach pci_0000_01_00_0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이제 호스트용으로 장치를 사용할 수 있습니다.

절차 9.7. virt-manager를 사용하여 게스트에서 PCI 장치 분리

가상 하드웨어 세부 정보 화면을 엽니다.

virt-manager 에서 장치가 포함된 가상 머신을 두 번 클릭합니다. 가상 하드웨어 세부 정보 표시 버튼을 선택하여 가상 하드웨어 목록을 표시합니다.그림 9.4. 가상 하드웨어 세부 정보 버튼

장치 선택 및 제거

왼쪽 패널의 가상 장치 목록에서 분리할 PCI 장치를 선택합니다.그림 9.5. 분리할 PCI 장치 선택

(제거) 버튼을 클릭하여 확인합니다. 이제 호스트용으로 장치를 사용할 수 있습니다.

(제거) 버튼을 클릭하여 확인합니다. 이제 호스트용으로 장치를 사용할 수 있습니다.

9.1.5. PCI 브리지 생성

9.1.6. PCI 패스스루

<소스> 요소에 의해 지정됨)는 먼저 장치의 MAC 주소를 구성된 값으로 설정하고 선택적으로 지정된 <가상 포트 요소를 사용하여 장치를 802.1Qbhable 스위치와 연결한 후 type='direct' 네트워크 장치에 대해 지정한 가상> 포트의 예를 참조하십시오. 표준 단일 포트 PCI 이더넷 카드 드라이버 설계의 제한으로 인해 - SR-IOV(Single Root I/O Virtualization) 가상 기능(VF) 장치만 이러한 방식으로 할당할 수 있습니다. 표준 단일 포트 PCI 또는 PCIe 이더넷 카드를 게스트에 할당하려면 기존 <hostdev> 장치 정의를 사용합니다.

<type='hostdev'> 인터페이스에는 name 속성이 "vfio"로 설정된 선택적 드라이버 하위 요소가 있을 수 있습니다. 레거시 KVM 장치 할당을 사용하려면 name을 "kvm"으로 설정할 수 있습니다(또는 < <driver> ='kvm이 현재 기본값이므로 드라이버> 요소를 생략하기만 하면 됩니다.

<hostdev> 장치의 기능과 매우 유사합니다. 이 방법은 통과된 장치에 대한 MAC 주소와 <가상 포트를> 지정할 수 있다는 점입니다. 이러한 기능이 필요하지 않은 경우, SR-IOV를 지원하지 않는 표준 단일 포트 PCI, PCIe 또는 USB 네트워크 카드가 있는 경우(따라서 게스트 도메인에 할당된 후 재설정 중에 구성된 MAC 주소가 손실됨) 또는 0.9.11 이전 버전의 libvirt를 사용하는 경우 표준 <hostdev> 를 사용하여 장치를 <인터페이스 유형/dev 유형> 대신 게스트에 할당해야 합니다.

그림 9.6. PCI 장치 할당의 경우 XML

9.1.7. SR-IOV 장치를 사용하여 PCI 할당(Passthrough) 구성

<hostdev> 요소를 사용하여 기존 방식으로 게스트 가상 머신에 할당할 수 있지만 SR-IOV VF 네트워크 장치에는 영구적인 MAC 주소가 없으므로 호스트 물리적 머신이 재부팅될 때마다 게스트 가상 머신의 네트워크 설정을 다시 구성해야 하는 문제가 발생합니다. 이 문제를 해결하려면 VF를 호스트 물리적 머신에 할당하기 전에 MAC 주소를 설정해야 하며 게스트 가상 머신이 부팅될 때마다 이 주소를 설정해야 합니다. 이 MAC 주소와 다른 옵션을 할당하려면 절차 9.8. “SR-IOV에서 PCI 장치를 할당하기 위해 MAC 주소, vLAN 및 가상 포트 구성” 에 설명된 절차를 참조하십시오.

절차 9.8. SR-IOV에서 PCI 장치를 할당하기 위해 MAC 주소, vLAN 및 가상 포트 구성

<mac>,<vlan>, <virtualport> 요소가 <hostdev> 용으로 유효하지 않으므로 MAC 주소 할당, vLAN 태그 ID 할당 또는 가상 포트 할당과 같은 기능별 항목에는 <hostdev> 요소를 사용할 수 없습니다. <인터페이스 용으로 유효하므로 새 인터페이스> 유형에 대한 지원이 추가되었습니다(<인터페이스 type='hostdev'>). 이 새 인터페이스 장치 유형은 <인터페이스> 및 <hostdev> 의 하이브리드 역할을 합니다. 따라서 PCI 장치를 게스트 가상 머신에 할당하기 전에 libvirt 는 표시된 네트워크별 하드웨어/슬래버스(예: MAC 주소 설정, vLAN 태그 설정, 802.1Qbh 스위치)를 게스트 가상 머신의 XML 구성 파일에서 초기화합니다. vLAN 태그 설정에 대한 자세한 내용은 18.14절. “vLAN 태그 설정” 을 참조하십시오.

게스트 가상 머신 종료

virsh shutdown 명령( 14.9.1절. “게스트 가상 머신 종료”참조)을 사용하여 guestVM 이라는 게스트 가상 머신을 종료합니다.virsh shutdown guestVM

# virsh shutdown guestVMCopy to Clipboard Copied! Toggle word wrap Toggle overflow 정보 수집

<인터페이스 type='hostdev'>를 사용하려면 SR-IOV 가능 네트워크 카드, Intel VT-d 또는 AMD IOMMU 확장 기능을 지원하는 물리적 머신 하드웨어를 호스트해야 하며, 할당할 VF의 PCI 주소를 알아야 합니다.편집을 위해 XML 파일을 엽니다.

# virsh save-image-edit 명령을 실행하여 편집할 XML 파일을 엽니다(자세한 내용은 14.8.10절. “도메인 XML 구성 파일 편집” 참조). 게스트 가상 머신을 이전 실행 상태로 복원하려는 경우--running이 사용됩니다. 이 예제의 구성 파일의 이름은 게스트 가상 머신의 이름이 guestVM 이므로 guestVM.xml 입니다.virsh save-image-edit guestVM.xml --running

# virsh save-image-edit guestVM.xml --runningCopy to Clipboard Copied! Toggle word wrap Toggle overflow guestVM.xml 이 기본 편집기에서 열립니다.XML 파일 편집

구성 파일(guestVM.xml)을 다음과 유사한<장치>항목을 갖도록 업데이트합니다.그림 9.7. hostdev 인터페이스 유형의 샘플 도메인 XML

Copy to Clipboard Copied! Toggle word wrap Toggle overflow MAC 주소를 제공하지 않으면 다른 유형의 인터페이스 장치와 마찬가지로 MAC 주소가 자동으로 생성됩니다. 또한<virtualport>요소는 802.11Qgh 하드웨어 스위치 (802.11Qbg (a.k.a))에 연결하는 경우에만 사용됩니다. "VEPA") 스위치는 현재 지원되지 않습니다.게스트 가상 머신 다시 시작

virsh start 명령을 실행하여 첫 번째 단계에서 종료한 게스트 가상 머신을 재시작합니다(예: guestVM을 게스트 가상 시스템의 도메인 이름으로 사용). 자세한 내용은 14.8.1절. “정의된 도메인 시작” 를 참조하십시오.virsh start guestVM

# virsh start guestVMCopy to Clipboard Copied! Toggle word wrap Toggle overflow 게스트 가상 머신이 시작되면 실제 호스트 시스템의 어댑터에 의해 제공된 네트워크 장치가 구성된 MAC 주소와 함께 표시됩니다. 이 MAC 주소는 게스트 가상 시스템 및 호스트 물리적 시스템 재부팅 시 변경되지 않은 상태로 유지됩니다.

9.1.8. SR-IOV 가상 함수 풀에서 PCI 장치 할당 설정

- 지정된 VF는 게스트 가상 머신이 시작될 때마다 사용할 수 있어야 합니다. 즉, 관리자가 각 VF를 단일 게스트 가상 머신에 영구적으로 할당해야 합니다(또는 게스트 가상 머신이 시작될 때마다 사용되지 않는 VF의 PCI 주소를 지정하도록 모든 게스트 가상 머신의 구성 파일 수정).

- 게스트 가상 시스템이 다른 호스트 물리적 시스템으로 이동하는 경우 호스트 물리적 시스템은 PCI 버스의 동일한 위치에 동일한 하드웨어가 있어야 합니다(또는 다시 시작 전에 게스트 가상 머신 구성을 수정해야 함).

절차 9.9. 장치 풀 생성

게스트 가상 머신 종료

virsh shutdown 명령( 14.9절. “게스트 가상 시스템의 종료, 재부팅 및 종료”참조)을 사용하여 guestVM 이라는 게스트 가상 머신을 종료합니다.virsh shutdown guestVM

# virsh shutdown guestVMCopy to Clipboard Copied! Toggle word wrap Toggle overflow 구성 파일 생성

선택한 편집기를 사용하면/tmp디렉터리에 XML 파일(예: passthrough.xml )이 생성됩니다.pf dev='eth3'을 자체 SR-IOV 장치의 netdev 이름으로 교체해야 합니다.다음은 호스트 물리적 머신의 "eth3'에 있는 PF(물리 기능) 를 사용하여 SR-IOV 어댑터에 대한 모든 VF 풀을 사용할 수 있도록 하는 네트워크 정의 예제입니다.그림 9.8. 네트워크 정의 도메인 XML 샘플

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 새 XML 파일 로드

다음 명령을 실행하여 /tmp/passthrough.xml 을 이전 단계에서 생성한 XML 파일의 이름 및 위치로 바꿉니다.virsh net-define /tmp/passthrough.xml

# virsh net-define /tmp/passthrough.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 게스트 다시 시작

passthrough.xml 을 이전 단계에서 생성한 XML 파일의 이름으로 교체하여 다음을 실행합니다.virsh net-autostart passthrough # virsh net-start passthrough

# virsh net-autostart passthrough # virsh net-start passthroughCopy to Clipboard Copied! Toggle word wrap Toggle overflow 게스트 가상 머신 다시 시작

virsh start 명령을 실행하여 첫 번째 단계에서 종료한 게스트 가상 머신을 재시작합니다(예: guestVM을 게스트 가상 시스템의 도메인 이름으로 사용). 자세한 내용은 14.8.1절. “정의된 도메인 시작” 를 참조하십시오.virsh start guestVM

# virsh start guestVMCopy to Clipboard Copied! Toggle word wrap Toggle overflow 장치에 대한 패스스루 시작

단일 장치만 표시되지만 libvirt는 해당 PF와 연결된 모든 VF 목록을 자동으로 파생시킵니다. 그러면 다음과 같이 게스트 가상 머신이 도메인 XML의 인터페이스 정의로 처음 시작될 때 libvirt가 자동으로 파생됩니다.그림 9.9. 인터페이스 네트워크 정의를 위한 샘플 도메인 XML

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 검증

네트워크를 사용하는 첫 번째 게스트를 시작한 후 virsh net-dumpxml passthrough 명령을 실행하여 확인할 수 있습니다. 다음과 유사한 출력을 얻을 수 있습니다.그림 9.10. XML 덤프 파일 패스스루 콘텐츠

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

9.2. USB 장치

9.2.1. 게스트 가상 머신에 USB 장치 할당

- USB 패스스루 사용 - 이 경우 장치는 게스트 가상 머신을 호스팅하는 호스트 물리적 머신에 물리적으로 연결되어 있어야 합니다. 이 경우에는 SPICE가 필요하지 않습니다. 명령줄 또는 virt-manager 를 사용하여 호스트의 USB 장치를 게스트로 전달할 수 있습니다. 가상화 관리자 지침은 15.3.1절. “게스트 가상 머신에 USB 장치 연결” 를 참조하십시오.참고virt-manager 를 핫플러그 또는 연결 해제 장치에 사용해서는 안 됩니다. USB 장치를 핫 플러그/또는 핫 플러그 해제하려면 절차 14.1. “게스트 가상 머신에서 사용할 USB 장치 핫플러그” 을 참조하십시오.

- USB 리디렉션 사용 - 데이터 센터에서 실행 중인 호스트 물리적 시스템이 있는 경우 USB 리디렉션이 가장 적합합니다. 사용자는 로컬 머신 또는 씬 클라이언트에서 게스트 가상 머신에 연결합니다. 이 로컬 머신에는 SPICE 클라이언트가 있습니다. 사용자는 모든 USB 장치를 씬 클라이언트에 연결할 수 있으며 SPICE 클라이언트는 씬 클라이언트에서 실행되는 게스트 가상 시스템에서 사용할 수 있도록 장치를 데이터 센터의 호스트 물리적 시스템으로 리디렉션합니다. virt-manager 를 사용하여 USB 리디렉션에 대한 지침은 15.3.1절. “게스트 가상 머신에 USB 장치 연결” 를 참조하십시오. USB 리디렉션은 TCP 프로토콜을 사용할 수 없습니다( BZ#1085318참조).

9.2.2. USB 장치 리디렉션에서 제한 설정

-device usb-redir 에 전달합니다. filter 속성은 필터 규칙으로 구성된 문자열을 사용하며, 규칙의 형식은 다음과 같습니다.

<class>:<vendor>:<product>:<version>:<allow>

<class>:<vendor>:<product>:<version>:<allow>-1 을 사용하여 특정 필드에 대한 값을 수락하도록 지정합니다. |를 구분 기호로 사용하여 동일한 명령줄에서 여러 규칙을 사용할 수 있습니다.

예 9.1. Windows 게스트 가상 시스템으로 리디렉션 제한의 예

- Windows 7 게스트 가상 머신을 준비합니다.

- 게스트 가상 머신의 domain xml 파일에 다음 코드 발췌를 추가합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - guest 가상 머신을 시작하고 다음을 실행하여 설정 변경 사항을 확인합니다.

#ps -ef | grep $guest_name

#ps -ef | grep $guest_nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow -device usb-redir,chardev=charredir0,id=redir0,/ filter=0x08:0x1234:0xBEEF:0x0200:1|-1:-1:-1:-1:0,bus=usb.0,port=3

-device usb-redir,chardev=charredir0,id=redir0,/ filter=0x08:0x1234:0xBEEF:0x0200:1|-1:-1:-1:-1:0,bus=usb.0,port=3Copy to Clipboard Copied! Toggle word wrap Toggle overflow - USB 장치를 호스트 물리적 머신에 연결하고 virt-manager 를 사용하여 게스트 가상 머신에 연결합니다.

- 메뉴에서 클릭합니다. "호스트 정책에서 일부 USB 장치를 차단함"라는 메시지가 표시됩니다. 확인 을 클릭하여 확인하고 계속합니다.Click to confirm and continue.필터가 적용됩니다.

- 필터가 USB 장치 공급 업체 및 제품을 올바르게 확인하려면 USB 리디렉션을 허용하도록 게스트 가상 시스템의 도메인 XML에서 다음과 같이 변경합니다.

<redirfilter> <usbdev class='0x08' vendor='0x0951' product='0x1625' version='2.0' allow='yes'/> <usbdev allow='no'/> </redirfilter><redirfilter> <usbdev class='0x08' vendor='0x0951' product='0x1625' version='2.0' allow='yes'/> <usbdev allow='no'/> </redirfilter>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 게스트 가상 머신을 재시작한 다음 virt-viewer 를 사용하여 게스트 가상 머신에 연결합니다. 이제 USB 장치가 트래픽을 게스트 가상 머신으로 리디렉션합니다.

9.3. 장치 컨트롤러 구성

그림 9.11. 가상 컨트롤러의 도메인 XML 예

<컨트롤러 유형> 이 있으며 다음 중 하나여야 합니다.

- IDE

- fdc

- scsi

- SATA

- usb

- CCID

- virtio-serial

- pci

<컨트롤러> 요소에는 필수 특성 <컨트롤러 인덱스> 가 있으며, 이는 버스 컨트롤러가 발생하는 순서를 설명하는 10진수 정수입니다( <address> elements의 컨트롤러 특성에 사용). <controller type ='virtio-serial'> 에 두 개의 추가 선택적 속성(명명 포트 및 벡터)이 있는 경우 컨트롤러를 통해 연결할 수 있는 장치 수를 제어합니다. Red Hat Enterprise Linux 6는 장치당 32 벡터를 초과하는 사용을 지원하지 않습니다. 벡터를 더 많이 사용하면 게스트 가상 머신을 마이그레이션할 때 오류가 발생합니다.

<controller type ='scsi'> 의 경우 다음과 같은 값을 가질 수 있는 선택적 특성 모델 모델이 있습니다.

- auto

- buslogic

- ibmvscsi

- lsilogic

- lsisas1068

- lsisas1078

- virtio-scsi

- vmpvscsi

<controller type ='usb'> 의 경우 다음과 같은 값을 가질 수 있는 선택적 특성 모델 모델이 있습니다.

- piix3-uhci

- piix4-uhci

- ehci

- ich9-ehci1

- ich9-uhci1

- ich9-uhci2

- ich9-uhci3

- vt82c686b-uhci

- pci-ohci

- nec-xhci

<model='none'> 을 사용할 수 있습니다. .

<주소는> 컨트롤러의 마스터 버스와의 정확한 관계를 9.4절. “장치 주소 설정” 에 표시된 대로 지정할 수 있습니다.

<드라이버는 드라이버> 특정 옵션을 지정할 수 있습니다. 현재는 컨트롤러의 대기열 수를 지정하는 특성 대기열만 지원합니다. 최상의 성능을 위해 vCPU 수와 일치하는 값을 지정하는 것이 좋습니다.

<마스터> 컨트롤러와의 정확한 관계를 지정하기 위한 선택적 하위 요소 마스터가 있습니다. 파트너 컨트롤러는 마스터와 동일한 버스에 있으므로 companion index 값이 동일해야 합니다.

그림 9.12. USB 컨트롤러의 도메인 XML 예

모델 속성이 있습니다.

- pci-root

- pcie-root

- pci-bridge

- dmi-to-pci-bridge

pci-root 및 pcs ie-root)에는 64비트 PCI 홀트가 있어야 하는 pcihole64 요소 또는 pcihole64 의단위 속성(KB)을 지정하는 pcihole64 요소가 있습니다. 일부 게스트 가상 머신 (예: Windows Server 2003)은 단위가 비활성화 되지 않는 한 ( unit ='0'으로 설정) 충돌을 일으킬 수 있습니다.

index='0' 인 pci-root 컨트롤러가 자동으로 추가되어 PCI 장치를 사용해야 합니다. pci-root에는 주소가 없습니다. PCI 브리지는 model='pci-root' 에서 제공하는 하나의 버스에 배치할 장치가 너무 많거나 0보다 큰 PCI 버스 번호가 지정된 경우 자동으로 추가됩니다. PCI 브리지를 수동으로 지정할 수도 있지만 주소는 이미 지정된 PCI 컨트롤러에서 제공하는 PCI 버스만 참조해야 합니다. PCI 컨트롤러 인덱스에서 간격을 남겨 두면 구성이 유효하지 않을 수 있습니다. 다음 XML 예제를 <devices> 섹션에 추가할 수 있습니다.

그림 9.13. PCI 브리지의 도메인 XML 예

index='0 을 사용하는pcie-root 컨트롤러가 도메인 구성에 자동 추가됩니다.pcie-root는 주소가 없지만 31 슬롯(수적으로 1-31)을 제공하는 데도 사용할 수 있습니다. PCie-root 컨트롤러가 있는 시스템에서 표준 PCI 장치를 연결하기 위해 model='dmi-to-pci-bridge' 가 있는 pci 컨트롤러가 자동으로 추가됩니다. dmi-to-pci-bridge 컨트롤러 플러그 인은 PCIe 슬롯에 플러그인하고(pcie-root에서 제공하는 대로) 31 표준 PCI 슬롯을 제공합니다(hot-pluggable). 게스트 시스템에 핫플러그 가능한 PCI 슬롯을 사용하기 위해 pci-bridge 컨트롤러도 자동으로 생성되고 자동 생성된 dmi-to-pci-bridge 컨트롤러 슬롯 중 하나에 연결됩니다. PCI 주소가 있는 모든 게스트 장치도 이 pci-bridge 장치에 배치됩니다.

그림 9.14. PCIe(PCI express)의 도메인 XML 예

9.4. 장치 주소 설정

<주소> 하위 요소가 있습니다. 입력 시 주소(또는 주소 내의 선택적 속성)를 생략하면 libvirt 에서 적절한 주소를 생성합니다. 그러나 레이아웃을 추가로 제어해야 하는 경우 명시적 주소가 필요합니다. <address> 요소를 포함한 도메인 XML 장치 예제는 그림 9.6. “PCI 장치 할당의 경우 XML” 를 참조하십시오.

유형이 있습니다. 지정된 장치에 사용할 주소 중 일부는 장치 및 게스트 가상 머신의 아키텍처가 제한됩니다. 예를 들어, <디스크> 장치는 type='drive' 를 사용하지만 <콘솔> 장치는 i686 또는 x86_64 게스트 가상 머신 아키텍처 에서 type='pci' 을 사용합니다. 각 주소 유형에는 장치가 표에 설명된 대로 배치되는 버스 위치를 제어하는 추가 선택적 속성이 있습니다.

| 주소 유형 | 설명 |

|---|---|

| type='pci' | PCI 주소에는 다음과 같은 추가 속성이 있습니다.

|

| type='drive' | 드라이브 주소에는 다음과 같은 추가 속성이 있습니다.

|

| type='virtio-serial' | 각 virtio-serial 주소에는 다음과 같은 추가 속성이 있습니다.

|

| type='ccid' | 스마트 카드의 경우 CCID 주소에는 다음과 같은 추가 속성이 있습니다.

|

| type='usb' | USB 주소에는 다음과 같은 추가 속성이 있습니다.

|

| type='isa' | ISA 주소에는 다음과 같은 추가 속성이 있습니다.

|

9.5. 게스트 가상 머신의 스토리지 컨트롤러 관리

- virtio-scsi 컨트롤러를 통해 가상 하드 드라이브 또는 CD를 연결합니다.

- QEMU scsi-block 장치를 통해 호스트에서 게스트로 물리적 SCSI 장치를 전달합니다.

- 게스트당 수백 개의 장치를 사용할 수 있습니다. virtio-blk의 28 장치 제한을 개선할 수 있습니다.

절차 9.10. 가상 SCSI 컨트롤러 생성

- 게스트 가상 머신(

Guest1)의 구성을 표시하고 기존 SCSI 컨트롤러를 찾습니다.virsh dumpxml Guest1 | grep controller.*scsi

# virsh dumpxml Guest1 | grep controller.*scsiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 장치 컨트롤러가 있는 경우 명령은 다음과 유사한 하나 이상의 행을 출력합니다.<controller type='scsi' model='virtio-scsi' index='0'/>

<controller type='scsi' model='virtio-scsi' index='0'/>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 이전 단계에서 장치 컨트롤러가 표시되지 않은 경우 다음 단계를 사용하여 새 파일에서 하나의 설명에 생성하고 가상 머신에 추가합니다.

- 새 파일에 <

controller>요소를 작성하여 장치 컨트롤러를 생성하고 XML 확장자로 이 파일을 저장합니다.virtio-scsi-controller.xml(예:<controller type='scsi' model='virtio-scsi'/>

<controller type='scsi' model='virtio-scsi'/>Copy to Clipboard Copied! Toggle word wrap Toggle overflow virtio-scsi-controller.xml에서 방금 생성한 장치 컨트롤러를 게스트 가상 머신(예: 1)과 연결합니다.virsh attach-device --config Guest1 ~/virtio-scsi-controller.xml

# virsh attach-device --config Guest1 ~/virtio-scsi-controller.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 예에서--config옵션은 디스크에 대해 수행하는 것과 동일하게 작동합니다. 자세한 내용은 절차 13.2. “게스트에 물리적 블록 장치 추가” 를 참조하십시오.

- 새 SCSI 디스크 또는 CD-ROM을 추가합니다. 새 디스크는 13.3.1절. “ 게스트에 파일 기반 스토리지 추가” 및 13.3.2절. “게스트에 하드 드라이브 및 기타 블록 장치 추가” 섹션의 방법을 사용하여 추가할 수 있습니다. SCSI 디스크를 만들려면 sd 로 시작하는 대상 장치 이름을 지정합니다.

virsh attach-disk Guest1 /var/lib/libvirt/images/FileName.img sdb --cache none

# virsh attach-disk Guest1 /var/lib/libvirt/images/FileName.img sdb --cache noneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 게스트 가상 머신의 드라이버 버전에 따라 실행 중인 게스트 가상 머신에 의해 새 디스크가 즉시 감지되지 않을 수 있습니다. Red Hat Enterprise Linux 스토리지 관리 가이드 의 단계를 따르십시오.

9.6. RNG(random Number Generator) 장치

virtio-rng 는 게스트 가상 머신의 운영 체제에 RNG 데이터를 제공하는 가상 RNG(random number generator) 장치로 요청 시 게스트 가상 머신에 새로운 엔트로피를 제공합니다.

virtio-rng 가 활성화된 경우 /dev/hwrng/.의 게스트 가상 시스템에 chardev가 생성됩니다. 그러면 이 chardev를 열고 호스트 물리적 시스템에서 엔트로피를 가져올 수 있습니다. 게스트 가상 머신의 애플리케이션이 투명하게 virtio-rng 장치의 임의성을 사용할 수 있도록 하려면 게스트 가상 머신의 커널 엔트로피 풀로 /dev/hwrng/ 의 입력을 릴레이해야 합니다. 이 위치의 정보가 rgnd 데몬(rng-tools 내에 포함된 포함)과 연결된 경우 이 작업을 수행할 수 있습니다.

/dev/random 파일로 라우팅됩니다. 이 프로세스는 Red Hat Enterprise Linux 6 게스트 가상 시스템에서 수동으로 수행됩니다.

rngd -b -r /dev/hwrng/ -o /dev/random/

# rngd -b -r /dev/hwrng/ -o /dev/random/viorng 드라이버를 설치해야 합니다. 가상 RNG 장치가 설치되면 Microsoft에서 제공하는 CNG(crypto 차세대) API를 사용하여 작동합니다. 드라이버가 설치되면 virtrng 장치가 RNG 공급자 목록에 나타납니다.

절차 9.11. 명령줄 툴을 사용하여 virtio-rng 구현

- 게스트 가상 머신을 종료합니다.

- 터미널 창에서 virsh edit domain-name 명령을 사용하여 원하는 게스트 가상 시스템에 대한 XML 파일을 엽니다.

- 다음을 포함하도록

<devices>요소를 편집합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

10장. QEMU-img 및 QEMU 게스트 에이전트

/usr/share/doc/qemu-*/README.systemtap 을 참조하십시오.

10.1. qemu-img 사용

확인

디스크 이미지 파일 이름에 대해 일관성 검사를 수행합니다.

qemu-img check -f qcow2 --output=qcow2 -r all filename-img.qcow2

# qemu-img check -f qcow2 --output=qcow2 -r all filename-img.qcow2qcow2 및 vdi 형식만 일관성 검사를 지원합니다.

-r 누수 s 클러스터 누수와 함께 사용하면 모든 종류의 오류가 수정됩니다. 이 경우 잘못된 수정 사항을 선택하거나 이미 발생한 손상 문제를 숨길 위험이 있습니다.

커밋

지정된 파일(파일이름)에 기록된 변경 사항을 qemu-img commit 명령을 사용하여 파일의 기본 이미지에 커밋합니다. 필요한 경우 파일의 형식 유형(형식)을 지정합니다.

qemu-img commit [-f format] [-t cache] filename

# qemu-img commit [-f format] [-t cache] filenameconvert

convert 옵션은 하나의 인식된 이미지 형식을 다른 이미지 형식으로 변환하는 데 사용됩니다.

qemu-img convert [-c] [-p] [-f format] [-t cache] [-O output_format] [-o options] [-S sparse_size] filename output_filename

# qemu-img convert [-c] [-p] [-f format] [-t cache] [-O output_format] [-o options] [-S sparse_size] filename output_filenamep 매개 변수는 명령의 진행 상황(선택 사항 및 모든 명령의 경우 아님)을 표시하며, -S 옵션을 사용하면 디스크 이미지에 포함된 스파스 파일을 생성할 수 있습니다. 스파스 파일은 모든 용도의 표준 파일처럼 작동합니다. 단, 0만 포함된 물리 블록(nothing)을 제외하면 됩니다. 운영 체제에서 이 파일을 볼 때 실제로는 아무것도 사용하지 않더라도 실제 디스크 공간이 존재하는 것으로 취급되며 실제 디스크 공간을 차지합니다. 이는 디스크가 디스크 공간보다 많은 디스크 공간을 차지하는 것처럼 게스트 가상 머신에 대한 디스크를 만들 때 특히 유용합니다. 예를 들어 10Gb인 디스크 이미지에서 -S를 50Gb로 설정하면 10Gb의 디스크 공간만 실제로 사용되고 있지만 10Gb의 디스크 공간 크기는 60Gb로 나타납니다.

output_format 형식을 사용하여 디스크 이미지 파일 이름을 디스크 이미지 output_ filename 으로 변환합니다. 디스크 이미지는 선택적으로 -c 옵션으로 압축하거나, -o encryption 를 설정하여 -o 옵션으로 암호화할 수 있습니다. o 매개 변수와 함께 사용할 수 있는 옵션은 선택한 형식과 다릅니다.

qcow2 형식만 암호화 또는 압축을 지원합니다. qcow2 암호화는 보안 128비트 키와 함께 AES 형식을 사용합니다. qcow2 압축은 읽기 전용이므로 압축된 섹터를 qcow2 형식에서 변환하면 압축되지 않은 데이터로 새 형식으로 작성됩니다.

create

크기 및 포맷 의 새 디스크 이미지 파일 이름을 생성합니다.

qemu-img create [-f format] [-o options] filename [size][preallocation]

# qemu-img create [-f format] [-o options] filename [size][preallocation]

-o backing_file=filename 로 지정하면 이미지는 자체와 기본 이미지 간의 차이점만 기록합니다. commit 명령을 사용하지 않는 한 백업 파일은 수정되지 않습니다. 이 경우 크기를 지정할 필요가 없습니다.

-o preallocation=off|meta|full|falloc 입니다. 사전 할당된 메타데이터가 있는 이미지는 이미지보다 큽니다. 그러나 이미지 크기가 증가하는 경우 이미지가 증가함에 따라 성능이 향상됩니다.

전체 할당을 사용하면 이미지가 큰 데 시간이 오래 걸릴 수 있습니다. 전체 할당과 시간이 필요한 경우, falloc 를 사용하면 시간을 절약할 수 있습니다.

정보

info 매개 변수는 디스크 이미지 파일 이름에 대한 정보를 표시합니다. info 옵션의 형식은 다음과 같습니다.

qemu-img info [-f format] filename

# qemu-img info [-f format] filenameqcow2 이미지에서 가져온 공간 수를 표시합니다. 이 작업은 qemu-img 를 실행하여 수행됩니다. 사용 중인 이미지가 qemu-img check 명령과 함께 qemu-img info 명령의 출력과 일치하는지 확인할 수 있습니다. 10.1절. “qemu-img 사용” 에서 참조하십시오.

map

# qemu-img 맵 [-f format] [--output=output_format] 파일 이름 명령은 이미지 파일 이름의 메타데이터와 백업 파일 체인을 덤프합니다. 특히 이 명령은 백업 파일 체인에 할당하는 최상위 파일과 함께 지정된 파일의 모든 섹터의 할당 상태를 덤프합니다. 예를 들어 c.qcow2 → b.qcow2 → a.qcow2와 같은 체인이 있는 경우 a.qcow2가 원래 파일인 경우 b.qcow2 및 c.qcow2는 b.qcow2의 delta 파일입니다. 이 체인이 생성되면 일반 이미지 데이터를 저장하고 파일에 어떤 파일에 있는지와 파일 내에 있는 위치에 대한 정보를 저장합니다. 이러한 정보를 이미지 메타데이터라고 합니다. f 형식 옵션은 지정된 이미지 파일의 형식입니다. raw, qcow2, vhdx 및 vmdk와 같은 형식을 사용할 수 있습니다. 사용 가능한 출력 옵션은 human 및 json 입니다.

사용자가기본 설정입니다. 이 형식은 사람의 눈에 더 쉽게 읽을 수 있도록 설계되어 있으므로 이 형식을 구문 분석해서는 안 됩니다. 명확성과 단순성을 위해 기본사람형식은 파일의 0이 아닌 영역만 덤프합니다. 파일의 알려진 0 부분은 완전히 생략되며 체인 전체에 할당되지 않은 부분에도 적용됩니다. 명령을 실행하면 qemu-img 출력이 데이터를 읽을 수 있는 파일과 파일의 오프셋을 식별합니다. 출력은 네 개의 열이 있는 테이블로 표시됩니다. 처음 3 개는 16진수입니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - JSON 또는 JSON(JavaScript Object Notation)은 사람이 읽을 수 있지만 프로그래밍 언어이므로 구문 분석하도록 설계되었습니다.

예를 들어 구문 분석기에서 "qemu-img 맵"의 출력을 구문 분석하려면--output=json옵션을 사용해야 합니다.qemu-img map -f qcow2 --output=json /tmp/test.qcow2 [{ "start": 0, "length": 131072, "depth": 0, "zero": false, "data": true, "offset": 327680}, { "start": 131072, "length": 917504, "depth": 0, "zero": true, "data": false},# qemu-img map -f qcow2 --output=json /tmp/test.qcow2 [{ "start": 0, "length": 131072, "depth": 0, "zero": false, "data": true, "offset": 327680}, { "start": 131072, "length": 917504, "depth": 0, "zero": true, "data": false},Copy to Clipboard Copied! Toggle word wrap Toggle overflow JSON 형식에 대한 자세한 내용은 qemu-img(1) 매뉴얼 페이지를 참조하십시오.

Rebase

이미지의 백업 파일을 변경합니다.

qemu-img rebase [-f format] [-t cache] [-p] [-u] -b backing_file [-F backing_format] filename

# qemu-img rebase [-f format] [-t cache] [-p] [-u] -b backing_file [-F backing_format] filenameqcow2 형식만 백업 파일 변경(리베이스)을 지원합니다.

크기 조정

크기 크기로 생성된 것처럼 디스크 이미지 파일 이름을 변경합니다. 버전에 관계없이 원시 형식의 이미지만 크기를 조정할 수 있습니다. Red Hat Enterprise Linux 6.1 이상에서는 qcow2 형식의 이미지를 확장(하지만 축소할 수 없음)할 수 있는 기능이 추가되었습니다.

qemu-img resize filename size

# qemu-img resize filename size증가 하려는 바이트 수를 접두사로 추가하거나 - 는 해당 바이트 수만큼 디스크 이미지 크기를 줄입니다. 단위 접미사를 추가하면 킬로바이트(K), 메가바이트(M), 기가바이트(G) 또는 테라바이트(T)로 이미지 크기를 설정할 수 있습니다.

qemu-img resize filename [+|-]size[K|M|G|T]

# qemu-img resize filename [+|-]size[K|M|G|T]스냅샷

이미지의 기존스냅샷(파일이름)을 나열, 적용, 생성 또는 삭제합니다.

qemu-img snapshot [ -l | -a snapshot | -c snapshot | -d snapshot ] filename

# qemu-img snapshot [ -l | -a snapshot | -c snapshot | -d snapshot ] filename지원되는 형식

QEMU-img 는 다음 형식 중 하나로 파일을 변환하도록 설계되었습니다.

-

raw - 원시 디스크 이미지 형식(기본값). 가장 빠른 파일 기반 형식일 수 있습니다. 파일 시스템이 허점이 있는 경우(예: Windows의 Linux 또는 NTFS에서 ext2 또는 ext3의 ext3에서) 기록된 섹터만 공간을 예약합니다. qemu-img 정보를 사용하여 Unix/Linux에서 이미지 또는 ls -ls 에서 사용하는 실제 크기를 가져옵니다. 원시 이미지는 최적의 성능을 제공하지만 원시 이미지에서 매우 기본적인 기능만 사용할 수 있습니다(예: 스냅샷을 사용할 수 없음).

-

qcow2 - QEMU 이미지 형식: 최상의 기능을 갖춘 가장 유연한 형식인 QEMU 이미지 형식입니다. 이 도구를 사용하면 선택적 AES 암호화, zlib 기반 압축, 여러 VM 스냅샷 지원 및 소형 이미지(Windows의 비NTFS 파일 시스템)를 지원하지 않는 파일 시스템에서 유용합니다. 이 확장 기능 세트는 성능 비용으로 제공됩니다.

원시 또는 qcow2 형식으로 변환하기 위해 다음 형식을 인식하고 지원합니다. 이미지 형식은 일반적으로 자동으로 탐지됩니다. 이러한 형식을 raw 또는 qcow2 로 변환하는 것 외에도 raw 또는 qcow2 에서 원래 형식으로 변환할 수 있습니다.

- Bochs

- 디스크 이미지 형식입니다.

- cloop

- Linux Compressed loop 이미지, 예를 들어 Knoppix CD-ROM과 같이 직접 압축된 CD-ROM 이미지를 재사용할 수 있는 경우에만 유용합니다.

- cow

- User Mode Linux Copy On Write 이미지 형식입니다. cow 형식은 이전 버전과의 호환성을 위해서만 포함됩니다. Windows에서는 작동하지 않습니다.

- dmg

- Mac 디스크 이미지 형식입니다.

- nbd

- 네트워크 블록 장치.

- parallels

- 가상화 디스크 이미지 형식을 병렬로 지원합니다.

- QCOW

- 이전 QEMU 이미지 형식. 이전 버전과의 호환성을 위해서만 포함되어 있습니다.

- vdi

- Oracle VM350 하드 디스크 이미지 형식입니다.

- vmdk

- VMware 호환 이미지 형식(버전 1 및 2에 대한 읽기-쓰기 지원 및 버전 3에 대한 읽기 전용 지원).

- vpc

- Windows 가상 PC 디스크 이미지 형식입니다. 또한

vhd또는 Microsoft 가상 하드 디스크 이미지 형식이라고 합니다. - vvfat

- 가상 VFAT 디스크 이미지 형식입니다.

10.2. QEMU 게스트 에이전트

10.2.1. 게스트 에이전트 설치 및 활성화

10.2.2. 게스트 에이전트와 호스트 간의 통신 설정

절차 10.1. 게스트 에이전트와 호스트 간 통신 설정

게스트 XML을 엽니다.

QEMU 게스트 에이전트 구성으로 게스트 XML을 엽니다. 파일을 열려면 게스트 이름이 필요합니다. 호스트 시스템에서 # virsh list 명령을 사용하여 인식할 수 있는 게스트를 나열합니다. 이 예에서 게스트 이름은 rhel6 입니다.virsh edit rhel6

# virsh edit rhel6Copy to Clipboard Copied! Toggle word wrap Toggle overflow 게스트 XML 파일 편집

XML 파일에 다음 요소를 추가하고 변경 사항을 저장합니다.그림 10.1. 게스트 XML을 편집하여 QEMU 게스트 에이전트 구성

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 게스트에서 QEMU 게스트 에이전트 시작

아직 수행하지 않은 경우 yum install qemu-guest-agent 를 사용하여 게스트 가상 머신에서 게스트 에이전트를 다운로드하여 설치합니다. 설치가 완료되면 다음과 같이 서비스를 시작합니다.service start qemu-guest-agent

# service start qemu-guest-agentCopy to Clipboard Copied! Toggle word wrap Toggle overflow

10.2.3. QEMU 게스트 에이전트 사용

- qemu-guest-agent 는 클라이언트가 채널에 연결되어 있는지 여부를 탐지할 수 없습니다.

- 클라이언트에서 qemu-guest-agent 의 연결이 끊어졌는지 또는 백엔드에 다시 연결되었는지 여부를 감지할 수 있는 방법은 없습니다.

- virtio-serial 장치가 재설정되고 qemu-guest-agent 가 채널에 연결되지 않은 경우(일반적으로 재부팅 또는 핫 플러그로 인해) 클라이언트의 데이터가 삭제됩니다.

- qemu-guest-agent 가 virtio-serial 장치 재설정에 따라 채널에 연결된 경우 클라이언트의 데이터가 대기열에 추가되면(및 사용 가능한 버퍼가 소진되면 제한됨) qemu-guest-agent 가 계속 실행 중인지 여부와 관계없이 제한될 수 있습니다.

10.2.4. libvirt와 함께 QEMU 게스트 에이전트 사용

- virsh shutdown --mode=agent - 이 종료 방법은 QEMU 게스트 에이전트와 함께 사용되는 virsh shutdown --mode=acpi 보다 더 안정적입니다. 에이전트가 없으면 libvirt에서 ACPI 종료 이벤트 삽입에 의존하지만 일부 게스트에서는 해당 이벤트를 무시하므로 종료되지 않습니다.virsh reboot 에 대해 동일한 구문과 함께 사용할 수 있습니다.

- virsh snapshot-create --quiesce - 게스트가 스냅샷이 생성되기 전에 I/O를 안정적인 상태로 플러시할 수 있으므로 fsck를 수행하거나 부분 데이터베이스 트랜잭션을 손실하지 않고도 스냅샷을 사용할 수 있습니다. 게스트 에이전트는 게스트 공동 작업을 제공하여 높은 수준의 디스크 콘텐츠 안정성을 허용합니다.

- virsh setvcpus --guest - 게스트를 종료하여 CPU를 오프라인 상태로 전환합니다.

- virsh dompmsuspend - 게스트 운영 체제의 전원 관리 기능을 사용하여 실행 중인 게스트를 정상적으로 종료합니다.

10.2.5. 게스트 가상 머신 디스크 백업 생성

- 파일 시스템 애플리케이션/데이터베이스에서 작업 버퍼를 가상 디스크에 플러시하고 클라이언트 연결 수락을 중지합니다.

- 애플리케이션은 데이터 파일을 일관된 상태로 전환

- 기본 후크 스크립트 반환

- QEMU-ga 파일 시스템 및 관리 스택이 정지하는 경우 스냅샷 사용

- 스냅샷이 확인됨

- 파일 시스템 기능 재개

/etc/qemu-ga/fsfreeze-hook.d/.에서 표 10.1. “QEMU 게스트 에이전트 패키지 콘텐츠” 에 나열된 restorecon -FvvR 명령을 실행할 수 있습니다.

| 파일 이름 | 설명 |

|---|---|

/etc/rc.d/init.d/qemu-ga | QEMU 게스트 에이전트의 서비스 제어 스크립트(start/stop)입니다. |

/etc/sysconfig/qemu-ga | QEMU 게스트 에이전트의 구성 파일은 /etc/rc.d/init.d/qemu-ga 제어 스크립트에서 읽습니다. 설정은 쉘 스크립트 주석이 있는 파일에 설명되어 있습니다. |

/usr/bin/qemu-ga | QEMU 게스트 에이전트 바이너리 파일. |

/usr/libexec/qemu-ga/ | 후크 스크립트의 루트 디렉터리입니다. |

/usr/libexec/qemu-ga/fsfreeze-hook | 기본 후크 스크립트. 여기서는 수정할 필요가 없습니다. |

/usr/libexec/qemu-ga/fsfreeze-hook.d/ | 개별 애플리케이션별 후크 스크립트의 디렉터리입니다. 게스트 시스템 관리자는 후크 스크립트를 이 디렉터리에 수동으로 복사하고, 적절한 파일 모드 비트를 확인한 다음, 이 디렉터리에서 restorecon -FvvR 을 실행해야 합니다. |

/usr/share/qemu-kvm/qemu-ga/ | 샘플 스크립트가 있는 디렉터리(예: 용도만 해당). 여기에 포함된 스크립트는 실행되지 않습니다. |

/usr/libexec/qemu-ga/fsfreeze-hook 는 자체 메시지와 애플리케이션별 스크립트의 표준 출력 및 오류 메시지를 다음 로그 파일에서 기록합니다. /var/log/qemu-ga/fsfreeze-hook.log. 자세한 내용은 wiki.qemu.org 또는 libvirt.org 의 qemu-guest-agent wiki 페이지를 참조하십시오.

10.3. Windows 게스트에서 QEMU 게스트 에이전트 실행

- Windows XP 서비스 팩 3 (VSS는 지원되지 않음)

- Windows Server 2003 R2 - x86 및 AMD64 (VSS는 지원되지 않음)

- Windows Server 2008

- Windows Server 2008 R2

- Windows 7 - x86 및 AMD64

- Windows Server 2012

- Windows Server 2012 R2

- Windows 8 - x86 및 AMD64

- Windows 8.1 - x86 및 AMD64

절차 10.2. Windows 게스트에서 QEMU 게스트 에이전트 구성

Red Hat Enterprise Linux 호스트 머신 준비

Red Hat Enterprise Linux 호스트 물리적 머신에 다음 패키지가 설치되어 있는지 확인합니다.- virtio-win (

/usr/share/virtio-win/에 있음)

Windows 게스트에서 드라이버를 복사하려면 다음 명령을 사용하여 qxl 드라이버에 대한*.iso파일을 만듭니다.mkisofs -o /var/lib/libvirt/images/virtiowin.iso /usr/share/virtio-win/drivers

# mkisofs -o /var/lib/libvirt/images/virtiowin.iso /usr/share/virtio-win/driversCopy to Clipboard Copied! Toggle word wrap Toggle overflow Windows 게스트 준비

드라이버를 업데이트하려면*.iso를 Windows 게스트에 마운트하여 게스트에 virtio-serial driver를 설치합니다. 게스트를 시작한 다음, 표시된 대로 드라이버 .iso 파일을 게스트에 연결합니다( hdb라는 디스크를 사용).virsh attach-disk guest /var/lib/libvirt/images/virtiowin.iso hdb

# virsh attach-disk guest /var/lib/libvirt/images/virtiowin.iso hdbCopy to Clipboard Copied! Toggle word wrap Toggle overflow Windows 을 사용하여 드라이버를 설치하려면 다음 메뉴로 이동합니다.- virtio-win 드라이버를 설치하려면 > > 선택합니다.

Windows 게스트 XML 구성 파일 업데이트

Windows 게스트의 게스트 XML 파일은 Red Hat Enterprise Linux 호스트 머신에 있습니다. 이 파일에 액세스하려면 Windows 게스트 이름이 필요합니다. 호스트 시스템에서 # virsh list 명령을 사용하여 인식할 수 있는 게스트를 나열합니다. 이 예에서 게스트 이름은 win7x86입니다.# virsh edit win7x86 명령을 사용하여 XML 파일에 다음 요소를 추가하고 변경 사항을 저장합니다. 이 예에서 win7x86.agent 라는 호스트에서 소스 소켓 이름은 고유해야 합니다.그림 10.2. Windows 게스트 XML을 편집하여 QEMU 게스트 에이전트 구성

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Windows 게스트 재부팅

Windows 게스트를 재부팅하여 변경 사항을 적용합니다.virsh reboot win7x86

# virsh reboot win7x86Copy to Clipboard Copied! Toggle word wrap Toggle overflow Windows 게스트에서 QEMU 게스트 에이전트 준비

Windows 게스트에서 게스트 에이전트를 준비하려면 다음을 수행합니다.최신 virtio-win 패키지 설치

Red Hat Enterprise Linux 호스트 물리적 시스템 터미널 창에서 다음 명령을 실행하여 설치할 파일을 찾습니다. 아래에 표시된 파일은 시스템이 찾은 것과 정확히 동일하지 않을 수 있지만 최신 공식 버전이어야 합니다.rpm -qa|grep virtio-win virtio-win-1.6.8-5.el6.noarch rpm -iv virtio-win-1.6.8-5.el6.noarch

# rpm -qa|grep virtio-win virtio-win-1.6.8-5.el6.noarch # rpm -iv virtio-win-1.6.8-5.el6.noarchCopy to Clipboard Copied! Toggle word wrap Toggle overflow 설치가 완료되었는지 확인합니다.

virtio-win 패키지 설치가 완료되면/usr/share/virtio-win/guest-agent/폴더를 확인하고 qemu-ga-x64.msi 또는 qemu-ga-x86.msi라는 파일을 찾을 수 있습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow .msi 파일 설치

Windows 게스트(예:win7x86)에서 qemu-ga-x64.msi를 두 번 클릭하여 qemu-ga-x86.msi를 설치합니다. 설치가 완료되면 시스템 관리자 내에서 Windows 게스트에 qemu-ga 서비스로 표시됩니다. 이 동일한 관리자를 사용하여 서비스 상태를 모니터링할 수 있습니다.

10.3.1. Windows 게스트의 QEMU 게스트 에이전트와 함께 libvirt 명령 사용

- virsh shutdown --mode=agent - 이 종료 방법은 QEMU 게스트 에이전트와 함께 사용되는 virsh shutdown --mode=acpi 보다 더 안정적입니다. 에이전트가 없으면 libvirt에서 ACPI 종료 이벤트 삽입에 의존하지만 일부 게스트에서는 해당 이벤트를 무시하므로 종료되지 않습니다.virsh reboot 에 대해 동일한 구문과 함께 사용할 수 있습니다.

- virsh snapshot-create --quiesce - 게스트가 스냅샷이 생성되기 전에 I/O를 안정적인 상태로 플러시할 수 있으므로 fsck를 수행하거나 부분 데이터베이스 트랜잭션을 손실하지 않고도 스냅샷을 사용할 수 있습니다. 게스트 에이전트는 게스트 공동 작업을 제공하여 높은 수준의 디스크 콘텐츠 안정성을 허용합니다.

- virsh dompmsuspend - 게스트 운영 체제의 전원 관리 기능을 사용하여 실행 중인 게스트를 정상적으로 종료합니다.

10.4. 장치 리디렉션에서 제한 설정

-device usb-redir 에 전달합니다. filter 속성은 필터 규칙으로 구성된 문자열을 사용합니다. 규칙 형식은 다음과 같습니다.

<class>:<vendor>:<product>:<version>:<allow>

<class>:<vendor>:<product>:<version>:<allow>-1 을 사용하여 특정 필드에 대한 값을 수락하도록 지정합니다. |를 구분 기호로 사용하여 동일한 명령줄에서 여러 규칙을 사용할 수 있습니다. 장치가 필터 규칙과 일치하지 않으면 리디렉션이 허용되지 않습니다.

예 10.1. Windows 게스트 가상 머신으로 리디렉션 제한

- Windows 7 게스트 가상 머신을 준비합니다.

- 게스트 가상 머신의 XML 파일에 다음 코드 발췌를 추가합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - guest 가상 머신을 시작하고 다음을 실행하여 설정 변경 사항을 확인합니다.

ps -ef | grep $guest_name

# ps -ef | grep $guest_nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow -device usb-redir,chardev=charredir0,id=redir0,/ filter=0x08:0x1234:0xBEEF:0x0200:1|-1:-1:-1:-1:0,bus=usb.0,port=3

-device usb-redir,chardev=charredir0,id=redir0,/ filter=0x08:0x1234:0xBEEF:0x0200:1|-1:-1:-1:-1:0,bus=usb.0,port=3Copy to Clipboard Copied! Toggle word wrap Toggle overflow - USB 장치를 호스트 물리적 시스템에 연결하고 virt-viewer 를 사용하여 게스트 가상 머신에 연결합니다.

- 메뉴에서 클릭합니다. "호스트 정책에서 일부 USB 장치를 차단함"라는 메시지가 표시됩니다. 확인 을 클릭하여 확인하고 계속합니다.Click to confirm and continue.필터가 적용됩니다.

- 필터가 USB 장치 공급 업체 및 제품을 올바르게 확인하려면 USB 리디렉션을 허용하도록 호스트 물리적 시스템의 도메인 XML에서 다음과 같이 변경합니다.

<redirfilter> <usbdev class='0x08' vendor='0x0951' product='0x1625' version='2.0' allow='yes'/> <usbdev allow='no'/> </redirfilter><redirfilter> <usbdev class='0x08' vendor='0x0951' product='0x1625' version='2.0' allow='yes'/> <usbdev allow='no'/> </redirfilter>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 게스트 가상 머신을 재시작한 다음 virt-viewer 를 사용하여 게스트 가상 머신에 연결합니다. 이제 USB 장치가 트래픽을 게스트 가상 머신으로 리디렉션합니다.

10.5. 가상 NIC에 연결된 호스트 물리적 머신 또는 네트워크 브리지 변경

- 다음과 유사한 구성으로 게스트 가상 머신을 준비합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 인터페이스 업데이트를 위해 XML 파일을 준비합니다.

cat br1.xml

# cat br1.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 게스트 가상 머신을 시작하고 게스트 가상 머신의 네트워크 기능을 확인하고 게스트 가상 머신의 vnetX가 표시된 브리지에 연결되어 있는지 확인합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 다음 명령을 사용하여 새 인터페이스 매개변수로 게스트 가상 머신의 네트워크를 업데이트합니다.

virsh update-device test1 br1.xml Device updated successfully

# virsh update-device test1 br1.xml Device updated successfullyCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 게스트 가상 머신에서 서비스 네트워크를 다시 시작합니다. 게스트 가상 머신은 virbr1의 새 IP 주소를 가져옵니다. 게스트 가상 시스템의 vnet0이 새 브릿지(virbr1)에 연결되어 있는지 확인합니다.

brctl show bridge name bridge id STP enabled interfaces virbr0 8000.5254007da9f2 yes virbr0-nic virbr1 8000.525400682996 yes virbr1-nic vnet0

# brctl show bridge name bridge id STP enabled interfaces virbr0 8000.5254007da9f2 yes virbr0-nic virbr1 8000.525400682996 yes virbr1-nic vnet0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

11장. 스토리지 개념

11.1. 스토리지 풀

- virtio-blk = 2^63 바이트 또는 8 Exabytes( raw 파일 또는 디스크를 사용)

- Ext4 = ~ 16TB (4KB 블록 크기 사용)

- XFS = ~8 Exabytes

- qcow2 및 호스트 파일 시스템은 매우 큰 이미지 크기를 시도할 때 자체 메타데이터 및 확장성을 평가/tuned해야 합니다. 원시 디스크를 사용하면 확장성 또는 최대 크기에 영향을 줄 수 있는 레이어가 줄어듭니다.

/var/lib/libvirt/images/ 디렉터리를 기본 스토리지 풀로 사용합니다. 기본 스토리지 풀을 다른 스토리지 풀로 변경할 수 있습니다.

- 로컬 스토리지 풀 - 로컬 스토리지 풀이 호스트 물리적 시스템 서버에 직접 연결됩니다. 로컬 스토리지 풀에는 로컬 디렉터리, 직접 연결된 디스크, 물리적 파티션 및 LVM 볼륨 그룹이 포함됩니다. 이러한 스토리지 볼륨은 게스트 가상 머신 이미지를 저장하거나 게스트 가상 머신에 추가 스토리지로 연결됩니다. 로컬 스토리지 풀이 호스트 물리적 머신 서버에 직접 연결되므로 마이그레이션 또는 게스트 가상 머신 수가 필요하지 않은 개발, 테스트 및 소규모 배포에 유용합니다. 로컬 스토리지 풀은 실시간 마이그레이션을 지원하지 않으므로 로컬 스토리지 풀은 여러 프로덕션 환경에 적합하지 않습니다.