시스템 관리자 가이드

RHEL 7 배포, 구성 및 관리

초록

I 부. 기본 시스템 구성

이 부분에서는 기본적인 설치 후 작업 및 키보드 구성, 날짜 및 시간 구성, 사용자 및 그룹 관리 및 권한 얻기와 같은 기본 시스템 관리 작업에 대해 다룹니다.

1장. 시작하기

이 장에서는 Red Hat Enterprise Linux 7을 설치한 직후 수행해야 하는 기본 작업에 대해 설명합니다.

이러한 항목에는 설치 프로세스 중에 일반적으로 이미 수행되는 작업이 포함될 수 있지만 시스템 등록과 같이 반드시 수행해야 할 필요는 없습니다. 이러한 작업을 다루는 하위 관리자는 설치 및 특수 섹션의 관련 문서에 대한 링크에 대한 간략한 요약을 제공합니다.

Red Hat Enterprise Linux 7 설치에 대한 자세한 내용은 Red Hat Enterprise Linux 7 설치 가이드 를 참조하십시오.

이 장에서는 수행할 몇 가지 명령을 설명합니다. root 사용자가 입력해야 하는 명령에는 프롬프트에 # 이 있고 일반 사용자가 수행할 수 있는 명령에는 $ 가 있습니다.

일반적인 설치 후 작업에 대한 자세한 내용은 Red Hat Enterprise Linux 7 설치 가이드 를 참조하십시오.

명령줄을 통해 모든 설치 후 작업을 수행할 수 있지만 웹 콘솔 툴을 사용하여 일부 작업을 수행할 수도 있습니다.

What web console Is and Which Tasks it can be Used For

웹 콘솔 은 웹 브라우저를 통해 서버를 모니터링하고 관리하기 위한 사용자 인터페이스를 제공하는 시스템 관리 툴입니다.

웹 콘솔 을 사용하여 다음 작업을 수행할 수 있습니다.

- 하드웨어, 인터넷 연결 또는 성능 특성과 같은 기본 시스템 기능 모니터링

- 시스템 로그 파일의 내용 분석

- 인터페이스, 네트워크 로그, 패킷 크기와 같은 기본 네트워킹 기능 구성

- 사용자 계정 관리

- 시스템 서비스 모니터링 및 구성

- 진단 보고서 생성

- 커널 덤프 구성 설정

- SELinux 구성

- 시스템 서브스크립션 관리

- 터미널 액세스

웹 콘솔 설치 및 사용에 대한 자세한 내용은 RHEL 7 웹 콘솔 을 사용한 시스템 관리를 참조하십시오.

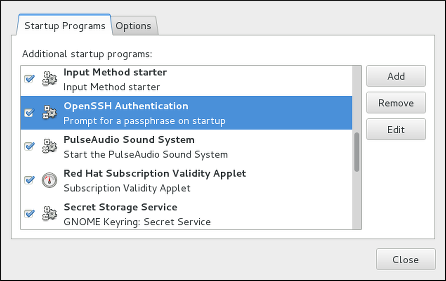

1.1. 환경의 기본 설정

환경의 기본 구성은 다음과 같습니다.

- 날짜 및 시간

- 시스템 지역

- 키보드 레이아웃

이러한 항목 설정은 일반적으로 설치 프로세스의 일부입니다.

자세한 내용은 설치 방법에 따라 적절한 소스를 참조하십시오.

Anaconda 설치 프로그램으로 설치할 때 다음을 참조하십시오.

Kickstart 파일로 설치하는 경우 다음을 참조하십시오.

Red Hat Enterprise Linux 7 설치 가이드의 Kickstart 명령 및 옵션 .

설치 후 환경의 기본 특성을 재구성해야 하는 경우 이 섹션의 지침을 따르십시오.

1.1.1. 날짜 및 시간 구성 소개

정확한 시간은 여러 가지 이유로 중요합니다. Red Hat Enterprise Linux 7에서 시간 유지는 NTP 프로토콜에 의해 확인되며, 이는 사용자 공간에서 실행되는 데몬에 의해 구현됩니다. 사용자 공간 데몬은 커널에서 실행되는 시스템 클럭을 업데이트합니다. 시스템 클럭은 다양한 클럭 소스를 사용하여 시간을 유지할 수 있습니다.

Red Hat Enterprise Linux 7은 다음 데몬을 사용하여 NTP 를 구현합니다.

chronydchronyd데몬은 기본적으로 사용됩니다. chrony 패키지에서 사용할 수 있습니다.chronyd에서NTP를 구성하고 사용하는 방법에 대한 자세한 내용은 18장. chrony Suite를 사용하여 NTP 설정 을 참조하십시오.ntpdntpd데몬은 ntp 패키지에서 사용할 수 있습니다.ntpd에서NTP설정 및 사용에 대한 자세한 내용은 19장. ntpd를 사용하여 NTP 설정 을 참조하십시오.

기본 chronyd 대신 ntpd 를 사용하려면 19장. ntpd를 사용하여 NTP 설정 에 표시된 대로 chronyd, install, enable 및 configure ntpd 를 비활성화해야 합니다.

현재 날짜 및 시간 표시

현재 날짜와 시간을 표시하려면 다음 명령 중 하나를 사용합니다.

date

~]$ datetimedatectl

~]$ timedatectl

timedatectl 명령은 현재 사용된 표준 시간대, NTP(Network Time Protocol) 구성 상태 및 몇 가지 추가 정보를 포함하여 보다 자세한 출력을 제공합니다.

날짜 및 시간 구성에 대한 자세한 내용은 3장. 날짜 및 시간 구성 을 참조하십시오.

1.1.2. 시스템 로컬 구성 소개

시스템 전체 로케일 설정은 systemd 데몬에서 초기 부팅 시 읽는 /etc/locale.conf 파일에 저장됩니다. /etc/locale.conf 에 구성된 로케일 설정은 개별 프로그램 또는 개별 사용자가 재정의하지 않는 한 모든 서비스 또는 사용자에 의해 상속됩니다.

시스템 로케일을 처리하는 기본 작업:

사용 가능한 시스템 로케일 설정 나열:

localectl list-locales

~]$ localectl list-localesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 시스템 로케일 설정의 현재 상태 표시:

localectl status

~]$ localectl statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow 기본 시스템 로케일 설정 또는 변경:

localectl set-locale LANG=locale

~]# localectl set-locale LANG=localeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

시스템 로케일 구성에 대한 자세한 내용은 2장. System Locale 및 keyboard Configuration 을 참조하십시오.

1.1.3. keyboard 레이아웃 구성 소개

키보드 레이아웃 설정은 텍스트 콘솔 및 그래픽 사용자 인터페이스에서 사용되는 레이아웃을 제어합니다.

키보드 레이아웃을 처리하는 기본 작업은 다음과 같습니다.

사용 가능한 키맵 나열:

localectl list-keymaps

~]$ localectl list-keymapsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 키 맵 설정의 현재 상태 표시:

localectl status

~]$ localectl statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow 기본 시스템 키맵 설정 또는 변경:

localectl set-keymap

~]# localectl set-keymapCopy to Clipboard Copied! Toggle word wrap Toggle overflow

키보드 레이아웃 구성에 대한 자세한 내용은 2장. System Locale 및 keyboard Configuration 을 참조하십시오.

1.2. 네트워크 액세스 구성 및 검사

네트워크 액세스는 일반적으로 설치 프로세스 중에 구성됩니다. 그러나 설치 프로세스에서는 일부 일반적인 설치 경로에서 네트워크 인터페이스를 구성하라는 메시지를 표시하지 않습니다. 따라서 설치 후 네트워크 액세스가 구성되지 않을 수 있습니다. 이 경우 설치 후 네트워크 액세스를 구성할 수 있습니다.

설치 중에 네트워크 액세스를 구성하는 빠른 시작 방법은 1.2.1절. “설치 프로세스 중 네트워크 액세스 구성” 을 참조하십시오. 설치 후 네트워크 액세스를 구성하려면 Red Hat Enterprise Linux 7 네트워킹 가이드 또는 Red Hat Enterprise Linux 7 네트워킹 가이드에 설명된 nmtui 텍스트 사용자 인터페이스 유틸리티에 설명된 nmcli 명령줄 유틸리티를 사용할 수 있습니다.

nmcli 및 nmtui 유틸리티에서는 하나 이상의 새 네트워크 연결을 추가하고 기존 연결을 수정 및 검사할 수 있습니다. nmcli 를 사용하여 네트워크 연결을 만들고 관리하려면 1.2.2절. “nmcli를 사용하여 설치 프로세스 후 네트워크 연결 관리” 을 참조하십시오. nmtui 를 사용하여 네트워크 연결을 생성 및 관리하려면 1.2.3절. “nmtui를 사용하여 설치 프로세스 후 네트워크 연결 관리” 을 참조하십시오.

1.2.1. 설치 프로세스 중 네트워크 액세스 구성

설치 프로세스 중에 네트워크 액세스를 구성하는 방법은 다음과 같습니다.

- Anaconda 설치 프로그램의 그래픽 사용자 인터페이스에 있는 설치 요약 화면에 있는 메뉴

- Anaconda 설치 프로그램의 텍스트 모드에 있는 옵션

- Kickstart 파일

설치가 완료된 후 시스템이 부팅되면 설치 중에 구성한 네트워크 인터페이스가 자동으로 활성화됩니다.

설치 프로세스 중 네트워크 액세스 구성에 대한 자세한 내용은 Red Hat Enterprise Linux 7 설치 가이드 를 참조하십시오.

1.2.2. nmcli를 사용하여 설치 프로세스 후 네트워크 연결 관리

nmcli 유틸리티를 사용하여 네트워크 연결을 관리하려면 root 사용자로 다음 명령을 실행합니다.

새 연결을 생성하려면 다음을 수행합니다.

nmcli con add type type of the connection "con-name" connection name ifname ifname interface-name the name of the interface ipv4 address ipv4 address gw4 address gateway address

~]# nmcli con add type type of the connection "con-name" connection name ifname ifname interface-name the name of the interface ipv4 address ipv4 address gw4 address gateway address기존 연결을 수정하려면 다음을 수행합니다.

nmcli con mod "con-name"

~]# nmcli con mod "con-name"모든 연결을 표시하려면 다음을 수행하십시오.

nmcli con show

~]# nmcli con show활성 연결을 표시하려면 다음을 수행합니다.

nmcli con show --active

~]# nmcli con show --active특정 연결의 모든 구성 설정을 표시하려면 다음을 수행합니다.

nmcli con show "con-name"

~]# nmcli con show "con-name"nmcli 명령줄 유틸리티에 대한 자세한 내용은 Red Hat Enterprise Linux 7 네트워킹 가이드 를 참조하십시오.

1.2.3. nmtui를 사용하여 설치 프로세스 후 네트워크 연결 관리

NetworkManager 텍스트 사용자 인터페이스(TUI) 유틸리티인 nmtui 는 NetworkManager 를 제어하여 네트워킹을 구성하는 텍스트 인터페이스를 제공합니다.

nmtui 텍스트 인터페이스 툴 설치 및 사용에 대한 자세한 내용은 Red Hat Enterprise Linux 7 네트워킹 가이드 를 참조하십시오.

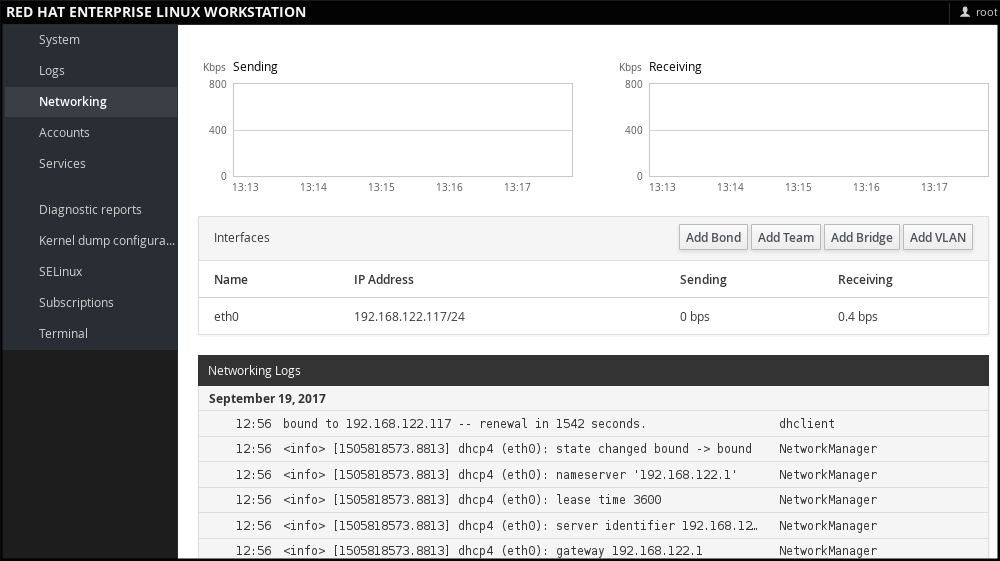

1.2.4. 웹 콘솔에서 네트워킹 관리

웹 콘솔에서 메뉴를 사용하면 됩니다.

- 현재 수신 및 전송된 패킷을 표시하려면 다음을 수행합니다.

- 사용 가능한 네트워크 인터페이스의 가장 중요한 특성 표시

- 네트워킹 로그의 콘텐츠를 표시하려면 다음을 수행합니다.

- 다양한 유형의 네트워크 인터페이스 추가 (bond, team, bridge, VLAN)

그림 1.1. 웹 콘솔에서 네트워킹 관리

1.3. 시스템 등록 및 서브스크립션 관리의 기본 사항

1.3.1. Red Hat 서브스크립션을 사용할 수 있는 작업은 무엇입니까?

운영 체제 자체를 포함하여 Red Hat Enterprise Linux 7에 설치된 제품은 서브스크립션을 통해 지원됩니다.

Red Hat Content Delivery Network에 대한 서브스크립션을 추적하는 데 사용됩니다.

- 등록된 시스템

- 해당 시스템에 설치된 제품

- 해당 제품에 연결된 서브스크립션

1.3.2. 설치 중 시스템 등록

이 섹션에서는 설치 프로세스 중 Red Hat Enterprise Linux 7 등록에 대한 간략한 요약을 제공합니다. 설치 후 운영 체제를 등록하지 않으면 이 섹션을 통해 설치 중에 누락된 내용을 확인할 수 있습니다. 자세한 내용은 Red Hat Enterprise Linux 7 설치 가이드 를 참조하십시오.

기본적으로 설치 중에 시스템을 등록하는 방법에는 두 가지가 있습니다.

- 일반적으로 등록은 초기 설정 구성 프로세스의 일부입니다. 자세한 내용은 Red Hat Enterprise Linux 7 설치 가이드 를 참조하십시오.

- 또 다른 옵션은 설치 후 스크립트 를 실행하는 것입니다. 이 스크립트는 설치가 완료되면 자동 등록을 수행하고 시스템을 처음 재부팅하기 전에 자동으로 등록합니다. 이를 위해 Kickstart 파일의 %post 섹션을 수정합니다. 설치 후 스크립트로 서브스크립션 관리자를 실행하는 방법에 대한 자세한 내용은 Red Hat Enterprise Linux 7 설치 가이드 를 참조하십시오.

1.3.3. 설치 후 시스템 등록

설치 과정에서 시스템을 등록하지 않은 경우 다음 절차를 적용하여 나중에 수행할 수 있습니다. 이 절차의 모든 명령은 root 사용자로 수행해야 합니다.

시스템 등록 및 등록

시스템을 등록합니다.

subscription-manager register

~]# subscription-manager registerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령은 Red Hat Customer Portal 사용자 이름과 암호를 입력하라는 메시지를 표시합니다.

필요한 서브스크립션의 풀 ID를 확인합니다.

subscription-manager list --available

~]# subscription-manager list --availableCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령은 Red Hat 계정에 사용 가능한 모든 서브스크립션을 표시합니다. 모든 서브스크립션에 대해 풀 ID를 포함하여 다양한 특성이 표시됩니다.

pool_id 를 이전 단계에서 확인한 풀 ID로 교체하여 시스템에 적절한 서브스크립션을 연결합니다.

subscription-manager attach --pool=pool_id

~]# subscription-manager attach --pool=pool_idCopy to Clipboard Copied! Toggle word wrap Toggle overflow

시스템 등록 및 Red Hat Content Delivery Network 서브스크립션 첨부에 대한 자세한 내용은 7장. 시스템 등록 및 서브스크립션 관리 을 참조하십시오.

1.3.4. EUS 콘텐츠에 시스템 등록

EUS (Extended Update Support) 콘텐츠에 액세스하려면 다음과 같이 시스템을 등록합니다.

EUS 인타이틀먼트를 사용할 수 있는지 확인합니다.

subscription-manager list --available --matches="*Extended Update Support"

~]# subscription-manager list --available --matches="*Extended Update Support"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow Pool ID를 사용하여 해당 서브스크립션을 연결합니다.

subscription-manager attach --pool 8a99f9ac7238188b01723d9c8a8a06a9

~]# subscription-manager attach --pool 8a99f9ac7238188b01723d9c8a8a06a9Copy to Clipboard Copied! Toggle word wrap Toggle overflow 시스템에 활성화된 기본 리포지토리를 EUS 변형으로 바꿉니다.

subscription-manager repos --disable \*

~]# subscription-manager repos --disable \*Copy to Clipboard Copied! Toggle word wrap Toggle overflow 사용 중인 RHEL 버전에 설정된 EUS 콘텐츠를 나타내는 리포지토리를 활성화합니다.

subscription-manager repos --enable rhel-7-server-eus-rpms

~]# subscription-manager repos --enable rhel-7-server-eus-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 최종 시스템에 필요한 릴리스 및 지원되는 릴리스를 선택합니다.

subscription-manager release --set 7.6

~]# subscription-manager release --set 7.6Copy to Clipboard Copied! Toggle word wrap Toggle overflow

현재 지원되는 EUS 릴리스는 연장 업데이트 지원 애드온 을 참조하십시오.

1.3.5. E4S 콘텐츠에 시스템 등록

다음 절차에서는 시스템을 등록하고 E4S 콘텐츠를 사용하는 방법을 설명합니다.

다음 명령을 사용하여 시스템을 등록합니다.

subscription-manager register

~]# subscription-manager registerCopy to Clipboard Copied! Toggle word wrap Toggle overflow E4S 인타이틀먼트를 사용할 수 있는지 확인합니다.

subscription-manager list --available --matches="*Update Services for SAP Solutions*"

~]# subscription-manager list --available --matches="*Update Services for SAP Solutions*"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow Pool ID를 사용하여 해당 서브스크립션을 연결합니다.

subscription-manager attach --pool=#################

~]# subscription-manager attach --pool=#################Copy to Clipboard Copied! Toggle word wrap Toggle overflow 시스템에 활성화된 기본 리포지토리를 EUS 변형으로 바꿉니다.

subscription-manager repos --disable="*"

~]# subscription-manager repos --disable="*"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 사용 중인 RHEL 버전에 설정된 E4S 콘텐츠를 나타내는 리포지토리를 활성화합니다.

subscription-manager --enable=rhel-7-server-e4s-rpms

~]# subscription-manager --enable=rhel-7-server-e4s-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 리포지토리 캐시 및 릴리스 잠금을 SAP 애플리케이션을 지원하는 E4S의 유효한 릴리스로 지웁니다.

yum clean all && subscription-manager release --set=7.7

~]# yum clean all && subscription-manager release --set=7.7Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.4. 소프트웨어 설치

이 섹션에서는 Red Hat Enterprise Linux 7 시스템에서 소프트웨어 설치의 기본 사항을 안내하는 정보를 제공합니다. 1.4.1절. “소프트웨어 설치를 위한 사전 요구 사항” 에 소프트웨어를 설치하기 위해 수행해야 하는 전제 조건을 언급하고, 1.4.2절. “소프트웨어 패키징 및 소프트웨어 리포지토리 시스템 소개” 의 소프트웨어 패키지 및 소프트웨어 리포지토리에 대한 기본 정보를 제공하고, 1.4.3절. “서브스크립션 관리자 및 YUM을 사용하여 기본 소프트웨어 설치 작업 관리” 의 소프트웨어 설치와 관련된 기본 작업을 수행하는 방법을 참조합니다.

1.4.1. 소프트웨어 설치를 위한 사전 요구 사항

Red Hat Content Delivery Network 서브스크립션 서비스는 Red Hat 소프트웨어 인벤토리를 처리하고 추가 소프트웨어 또는 이미 설치된 패키지를 설치할 수 있는 메커니즘을 제공합니다. 시스템을 등록하고 서브스크립션을 연결한 후 1.3절. “시스템 등록 및 서브스크립션 관리의 기본 사항” 에 설명된 대로 소프트웨어 설치를 시작할 수 있습니다.

1.4.2. 소프트웨어 패키징 및 소프트웨어 리포지토리 시스템 소개

Red Hat Enterprise Linux 시스템의 모든 소프트웨어는 특정 리포지토리에 저장된 RPM 패키지로 나뉩니다. Red Hat Content Delivery Network를 시스템이 서브스크립션하면 /etc/yum.repos.d/ 디렉토리에 리포지토리 파일이 생성됩니다.

yum 유틸리티를 사용하여 패키지 작업을 관리합니다.

- 패키지에 대한 정보 검색

- 패키지 설치

- 패키지 업데이트

- 패키지 제거

- 현재 사용 가능한 리포지토리 목록 확인

- 리포지토리 추가 또는 제거

- 리포지토리 활성화 또는 비활성화

소프트웨어 설치와 관련된 기본 작업에 대한 자세한 내용은 1.4.3절. “서브스크립션 관리자 및 YUM을 사용하여 기본 소프트웨어 설치 작업 관리” 을 참조하십시오. 소프트웨어 리포지토리 관리에 대한 자세한 내용은 7.2절. “소프트웨어 리포지토리 관리” 을 참조하십시오. yum 유틸리티 사용에 대한 자세한 내용은 9장. yum 을 참조하십시오.

1.4.3. 서브스크립션 관리자 및 YUM을 사용하여 기본 소프트웨어 설치 작업 관리

운영 체제를 설치한 후 필요할 수 있는 가장 기본적인 소프트웨어 설치 작업은 다음과 같습니다.

사용 가능한 모든 리포지토리 나열:

subscription-manager repos --list

~]# subscription-manager repos --listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 현재 활성화된 리포지토리를 모두 나열합니다.

yum repolist

~]$ yum repolistCopy to Clipboard Copied! Toggle word wrap Toggle overflow 리포지토리 활성화 또는 비활성화:

subscription-manager repos --enable repository

~]# subscription-manager repos --enable repositoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow subscription-manager repos --disable repository

~]# subscription-manager repos --disable repositoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 특정 문자열과 일치하는 패키지 검색:

yum search string

~]$ yum search stringCopy to Clipboard Copied! Toggle word wrap Toggle overflow 패키지 설치:

yum install package_name

~]# yum install package_nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 모든 패키지 및 해당 종속 항목을 업데이트합니다.

yum update

~]# yum updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow 패키지를 업데이트합니다.

yum update package_name

~]# yum update package_nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 패키지 및 패키지에 종속된 패키지 설치 제거:

yum remove package_name

~]# yum remove package_nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 설치 및 사용 가능한 모든 패키지에 대한 정보 나열:

yum list all

~]$ yum list allCopy to Clipboard Copied! Toggle word wrap Toggle overflow 설치된 모든 패키지에 대한 정보 나열:

yum list installed

~]$ yum list installedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.5. 부팅 시 systemd 서비스 시작

systemd는 systemd 단위의 개념을 소개하는 Linux 운영 체제용 시스템 및 서비스 관리자입니다. systemd에 대한 자세한 내용은 10.1절. “systemd 소개” 을 참조하십시오.

이 섹션에서는 부팅 시 서비스가 활성화 또는 비활성화되었는지 확인하는 방법에 대한 정보를 제공합니다. 또한 웹 콘솔 을 통해 서비스를 관리하는 방법을 설명합니다.

1.5.1. 서비스 활성화 또는 비활성화

설치 프로세스 중에 이미 부팅 시 활성화되거나 비활성화된 서비스를 확인하거나 설치된 운영 체제에서 서비스를 활성화하거나 비활성화할 수 있습니다.

설치 프로세스 중에 부팅 시 활성화되거나 비활성화되는 서비스 목록을 생성하려면 Kickstart 파일에서 services 옵션을 사용합니다.

services [--disabled=list] [--enabled=list]

services [--disabled=list] [--enabled=list]비활성화된 서비스 목록은 활성화된 서비스 목록보다 먼저 처리됩니다. 따라서 두 목록에 서비스가 모두 표시되면 활성화됩니다. 서비스 목록은 쉼표로 구분된 형식으로 제공해야 합니다. 서비스 목록에 공백을 포함하지 마십시오. 자세한 내용은 Red Hat Enterprise Linux 7 설치 가이드를 참조하십시오.

이미 설치된 운영 체제에서 서비스를 활성화하거나 비활성화하려면 다음을 수행합니다.

systemctl enableservice_name

~]# systemctl enableservice_namesystemctl disableservice_name

~]# systemctl disableservice_name자세한 내용은 10.2절. “시스템 서비스 관리”의 내용을 참조하십시오.

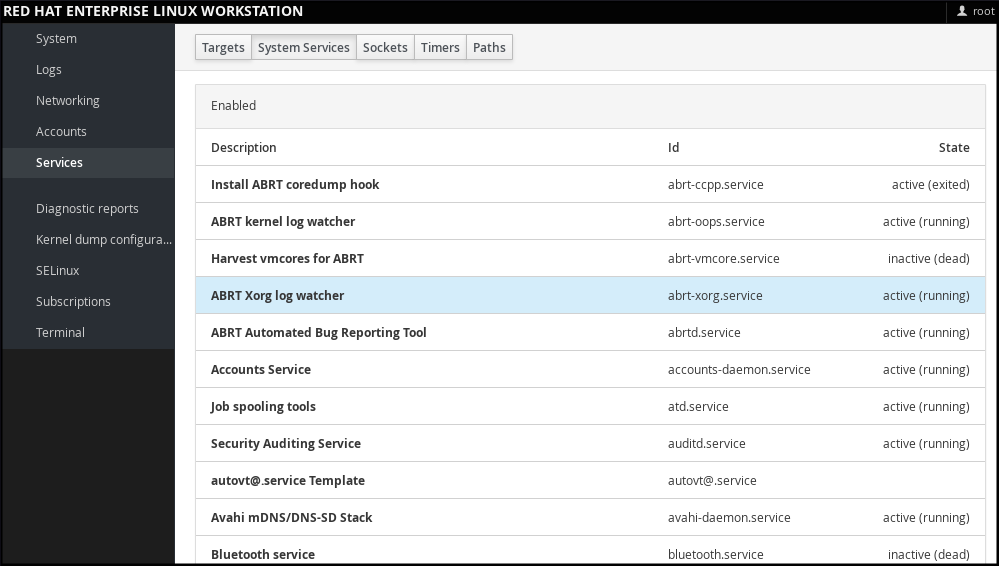

1.5.2. 웹 콘솔에서 서비스 관리

웹 콘솔에서 를 선택하여 systemd 대상, 서비스, 소켓, 타이머 및 경로를 관리합니다. 여기에서 자신의 상태를 확인, 시작 또는 중지, 활성화 또는 비활성화할 수 있습니다.

그림 1.2. 웹 콘솔에서 서비스 관리

1.5.3. systemd 서비스의 추가 리소스

systemd에 대한 자세한 내용은 10장. systemd를 사용하여 서비스 관리 을 참조하십시오.

1.6. 방화벽, SELinux 및 SSH 로그인으로 시스템 보안 강화

컴퓨터 보안은 컴퓨터 시스템을 하드웨어, 소프트웨어 또는 정보에 대한 도용 또는 손상으로부터 보호하는 것뿐 아니라 서비스 중단 또는 잘못된 방향을 보호하는 것입니다. 따라서 컴퓨터 보안을 보장하는 것은 기업이 민감한 데이터를 처리하거나 일부 비즈니스 트랜잭션을 처리하는 데 필요한 작업뿐만 아니라 필수 작업입니다.

컴퓨터 보안은 다양한 기능 및 도구를 포함합니다. 이 섹션에서는 운영 체제를 설치한 후 구성해야 하는 기본 보안 기능만 다룹니다. Red Hat Enterprise Linux 7 보안에 대한 자세한 내용은 Red Hat Enterprise Linux 7 보안 가이드 를 참조하십시오.

1.6.1. 방화벽 활성화 및 실행 확인

1.6.1.1. 방화벽의 취약점 및 시스템 보안 강화 방법

방화벽은 사전 결정된 보안 규칙을 기반으로 들어오고 나가는 네트워크 트래픽을 모니터링하고 제어하는 네트워크 보안 시스템입니다. 방화벽은 일반적으로 신뢰할 수 있고 안전한 내부 네트워크와 외부 네트워크 간의 장벽을 설정합니다.

Red Hat Enterprise Linux 7에서 방화벽은 Red Hat Enterprise Linux를 설치하는 동안 자동으로 활성화되는 firewalld 서비스에서 제공합니다. 그러나 Kickstart 구성과 같이 서비스를 명시적으로 비활성화한 경우 1.6.1.2절. “firewalld 서비스 다시 활성화” 에 설명된 대로 다시 활성화할 수 있습니다. Kickstart 파일의 방화벽 설정 옵션에 대한 개요는 Red Hat Enterprise Linux 7 설치 가이드 를 참조하십시오.

1.6.1.2. firewalld 서비스 다시 활성화

설치 후 firewalld 서비스가 비활성화되어 있는 경우 Red Hat은 이를 다시 활성화하는 것을 권장합니다.

일반 사용자로도 firewalld 의 현재 상태를 표시할 수 있습니다.

systemctl status firewalld

~]$ systemctl status firewalld

firewalld 가 활성화되어 실행되지 않으면 root 사용자로 전환하고 해당 상태를 변경합니다.

systemctl start firewalld

~]# systemctl start firewalldsystemctl enable firewalld

~]# systemctl enable firewalld

firewalld 와 관련된 설치 후 절차에 대한 자세한 내용은 Red Hat Enterprise Linux 7 보안 가이드 를 참조하십시오. 방화벽 설정 및 사용에 대한 자세한 내용은 Red Hat Enterprise Linux 7 보안 가이드를 참조하십시오.

1.6.2. SELinux 적용 상태 확인

1.6.2.1. SELinux의 정의 및 시스템 보안 강화 방법

SELinux(Security Enhanced Linux) 는 시스템 보안 계층을 통해 어떤 프로세스가 어떤 파일, 디렉터리 및 포트에 액세스할 수 있는지 결정합니다.

SELinux 상태

SELinux 에는 다음 두 가지 상태가 있습니다.

- enabled

- disabled

SELinux 가 비활성화된 경우 DC(Discretionary Access Control) 규칙만 사용됩니다.

SELinux 모드

SELinux 가 활성화되면 다음 모드 중 하나에서 실행할 수 있습니다.

- enforcing

- 허용

강제 모드는 SELinux 정책이 적용됨을 의미합니다. SELinux 는 SELinux 정책 규칙에 따라 액세스를 거부하고, 특히 허용되는 상호 작용만 활성화합니다. 강제 모드는 설치 후 기본 모드이며 가장 안전한 SELinux 모드이기도 합니다.

허용 모드는 SELinux 정책이 적용되지 않음을 의미합니다. SELinux 는 액세스를 거부하지 않지만 강제 모드에서 실행하는 경우 거부가 거부된 작업에 대해 기록됩니다. 허용 모드는 설치 중에 기본 모드입니다. 허용 모드에서는 문제를 해결할 때 AVC(Access Vector Cache) 거부에 액세스해야 하는 경우와 같이 특정 경우에 유용합니다.

Red Hat Enterprise Linux 7 의 SELinux 에 대한 자세한 내용은 Red Hat Enterprise Linux 7 SELinux 사용자 및 관리자 가이드 를 참조하십시오.

1.6.2.2. SELinux의 필수 상태 확인

기본적으로 SELinux 는 설치 중에 허용 모드로 작동하며 설치가 완료되면 강제 모드로 작동합니다.

그러나 일부 특정 상황에서는 SELinux 를 허용 모드로 명시적으로 설정하거나 설치된 운영 체제에서 비활성화할 수도 있습니다. 예를 들어 Kickstart 구성에서 이 값을 설정할 수 있습니다. Kickstart 파일의 SELinux 설정 옵션에 대한 개요는 Red Hat Enterprise Linux 7 설치 가이드 를 참조하십시오.

Red Hat은 시스템을 강제 모드로 유지할 것을 권장합니다.

현재 SELinux 모드를 표시하고 필요에 따라 모드를 설정하려면 다음을 수행합니다.

SELinux의 필수 상태 확인

현재 적용된 SELinux 모드를 표시합니다.

getenforce

~]$ getenforceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 필요한 경우 SELinux 모드를 전환합니다.

스위치는 일시적이거나 영구적일 수 있습니다. 영구 스위치는 재부팅 시 지속되지 않지만 임시 스위치는 재부팅 시 지속되지 않습니다.

강제 또는 허용 모드로 임시로 전환하려면 다음을 수행합니다.

setenforce Enforcing

~]# setenforce EnforcingCopy to Clipboard Copied! Toggle word wrap Toggle overflow setenforce Permissive

~]# setenforce PermissiveCopy to Clipboard Copied! Toggle word wrap Toggle overflow SELinux 모드를 영구적으로 설정하려면

/etc/selinux/config구성 파일에서 SELINUX 변수를 수정합니다.예를 들어 SELinux 를 강제 모드로 전환하려면 다음을 수행합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

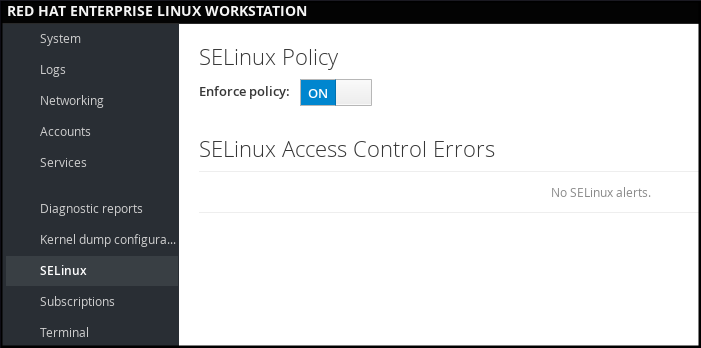

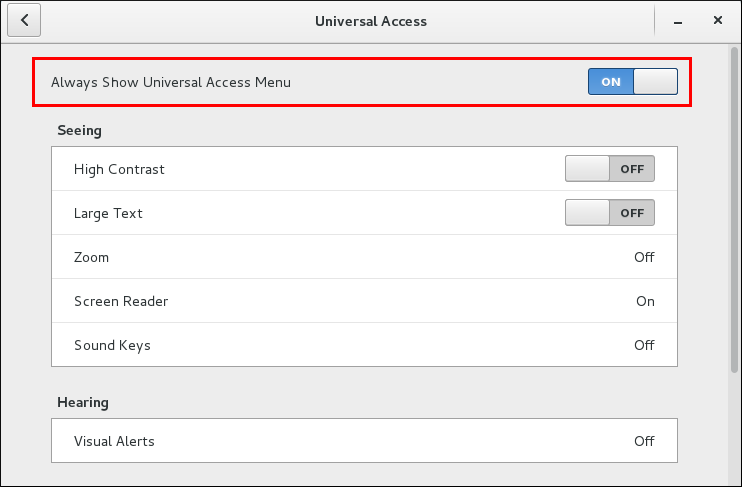

1.6.2.3. 웹 콘솔에서 SELinux 관리

웹 콘솔에서 강제 정책을 설정하거나 해제하려면 SELinux 옵션을 사용합니다.

기본적으로 웹 콘솔 의 SELinux 강제 정책은 설정되어 있으며 SELinux 는 강제 모드로 작동합니다. 이 모드를 해제하면 SELinux 를 허용 모드로 전환할 수 있습니다. /etc/sysconfig/selinux 파일의 기본 구성에서 이러한 비교는 다음 부팅 시 자동으로 되돌아갑니다.

그림 1.3. 웹 콘솔에서 SELinux 관리

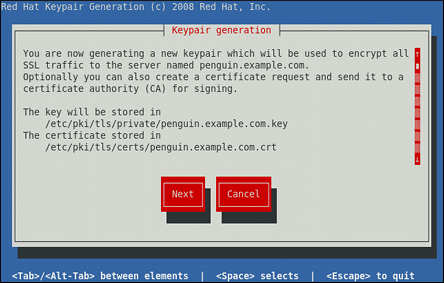

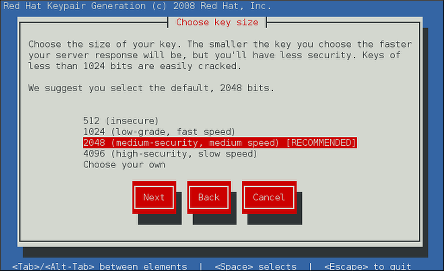

1.6.3. SSH 기반 인증 사용

1.6.3.1. SSH 기반 인증 및 시스템 보안을 조정하는 방법

다른 컴퓨터와의 통신을 보호하려면 SSH 기반 인증을 사용할 수 있습니다.

SSH(Secure Shell)는 클라이언트-서버 통신을 용이하게 하고 사용자가 SSH를 원격으로 실행하는 모든 호스트 시스템에 로그인할 수 있는 프로토콜입니다. SSH가 연결을 암호화합니다. 클라이언트는 암호화를 사용하여 인증 정보를 서버로 전송하며 세션 중에 전송되고 수신되는 모든 데이터는 암호화로 전송됩니다.

SSH를 사용하면 사용자가 암호 없이 인증할 수 있습니다. 이를 위해 SSH는 개인-공개 키 스키마를 사용합니다.

SSH 보호 장치에 대한 자세한 내용은 12.1.2절. “주요 기능” 을 참조하십시오.

1.6.3.2. SSH 연결 설정

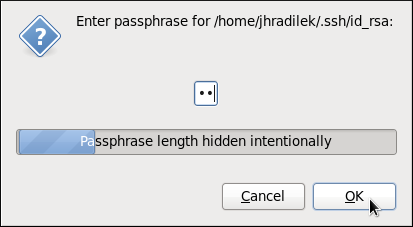

SSH 연결을 사용할 수 있으려면 공개 키와 개인 키로 구성된 두 개의 키 쌍을 만듭니다.

키 파일 생성 및 서버에 Them 복사

공개 및 개인 키를 생성합니다.

ssh-keygen

~]$ ssh-keygenCopy to Clipboard Copied! Toggle word wrap Toggle overflow 두 키는 모두

~/.ssh/디렉터리에 저장됩니다.-

~/.ssh/id_rsa.pub- public key ~/.SSH/id_rsa- 개인 키공개 키는 시크릿일 필요가 없습니다. 개인 키를 확인하는 데 사용됩니다. 개인 키는 시크릿입니다. 키 생성 프로세스 중에 지정한 암호로 개인 키를 보호하도록 선택할 수 있습니다. 암호를 사용하면 인증은 더 안전하지만 더 이상 암호가 제공되지 않습니다.

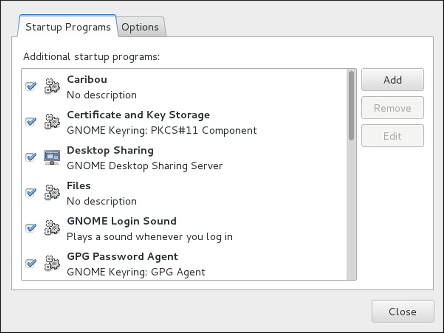

ssh-agent명령을 사용하여 이를 방지할 수 있습니다. 이 경우 세션이 시작될 때 한 번만 암호를 입력합니다.ssh-agent구성에 대한 자세한 내용은 12.2.4절. “키 기반 인증 사용” 을 참조하십시오.

-

가장 최근에 수정된 공개 키를 로그인하려는 원격 머신에 복사합니다.

ssh-copy-id USER@hostname

~]# ssh-copy-id USER@hostnameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 따라서 이제 안전한 방법으로 시스템을 입력할 수 있지만 암호를 입력하지 않아도 됩니다.

1.6.3.3. SSH 루트 로그인 비활성화

시스템 보안을 강화하기 위해 기본적으로 활성화되어 있는 root 사용자의 SSH 액세스를 비활성화할 수 있습니다.

이 항목에 대한 자세한 내용은 Red Hat Enterprise Linux 7 보안 가이드 를 참조하십시오.

SSH 루트 로그인 비활성화

/etc/ssh/sshd_config파일에 액세스합니다.vi /etc/ssh/sshd_config

~]# vi /etc/ssh/sshd_configCopy to Clipboard Copied! Toggle word wrap Toggle overflow #PermitRootLogin yes를 다음과 같이 읽는 행을 변경합니다.PermitRootLogin no

PermitRootLogin noCopy to Clipboard Copied! Toggle word wrap Toggle overflow sshd서비스를 다시 시작합니다.systemctl restart sshd

~]# systemctl restart sshdCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.7. 사용자 계정 관리의 기본 사항

Red Hat Enterprise Linux 7은 다중 사용자 운영 체제로, 다른 컴퓨터에서 여러 사용자가 한 컴퓨터에 설치된 단일 시스템에 액세스할 수 있습니다. 모든 사용자는 자체 계정으로 운영되며 사용자 계정을 관리하여 Red Hat Enterprise Linux 시스템 관리의 핵심 요소를 나타냅니다.

일반 및 시스템 계정

특정 시스템의 사용자를 위해 일반 계정이 생성됩니다. 이러한 계정은 일반 시스템 관리 중에 추가, 제거 및 수정할 수 있습니다.

시스템 계정은 시스템의 특정 애플리케이션 식별자를 나타냅니다. 이러한 계정은 일반적으로 소프트웨어 설치 시에만 추가되거나 조작되며 나중에 수정되지 않습니다.

시스템에서 로컬로 시스템 계정을 사용할 수 있다고 가정합니다. LDAP 구성 인스턴스에서와 같이 이러한 계정이 원격으로 구성되고 제공되는 경우 시스템 중단 및 서비스 시작 오류가 발생할 수 있습니다.

시스템 계정의 경우 1000 미만의 사용자 ID가 예약됩니다. 일반 계정의 경우 1000부터 시작하는 ID를 사용할 수 있습니다. 그러나 권장 사례는 5000에서 시작하는 ID를 할당하는 것입니다. 자세한 내용은 4.1절. “사용자 및 그룹 소개”를 참조하십시오. ID 할당 지침은 /etc/login.defs 파일에서 확인할 수 있습니다.

어떤 그룹들이 있고, 어떤 용도로 사용됩니까?

그룹은 특정 파일에 대한 액세스 권한 부여와 같은 공통 목적을 위해 여러 사용자 계정을 함께 연결하는 엔티티입니다.

1.7.1. 사용자 계정 및 그룹을 관리하는 가장 기본적인 명령줄 도구

사용자 계정 및 그룹을 관리하는 가장 기본적인 작업과 적절한 명령줄 툴은 다음과 같습니다.

사용자 및 그룹 ID 표시:

id

~]$ idCopy to Clipboard Copied! Toggle word wrap Toggle overflow 새 사용자 계정 생성:

useradd [options] user_name

~]# useradd [options] user_nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 사용자 이름에 속하는 사용자 계정에 새 암호를 할당합니다.

passwd user_name

~]# passwd user_nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 그룹에 사용자 추가:

usermod -a -G group_name user_name

~]# usermod -a -G group_name user_nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow

사용자 및 그룹 관리에 대한 자세한 내용은 4장. 사용자 및 그룹 관리 을 참조하십시오.

그래픽 사용자 인터페이스를 사용하여 사용자 및 그룹을 관리하려면 4.2절. “그래픽 환경에서 사용자 관리” 을 참조하십시오.

1.7.2. 웹 콘솔에서 사용자 계정 관리

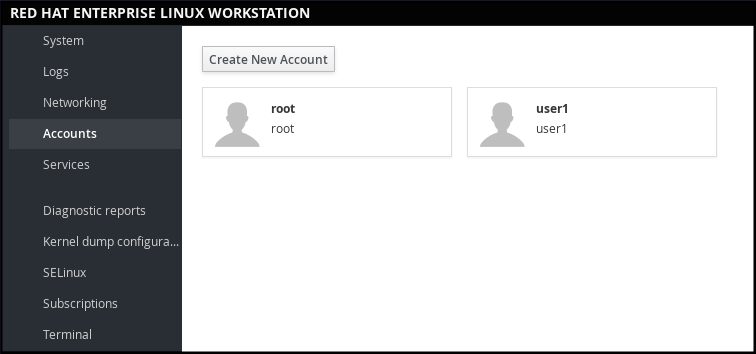

웹 콘솔 에서 계정을 관리하려면 메뉴를 선택합니다.

그림 1.4. 웹 콘솔에서 사용자 계정 관리

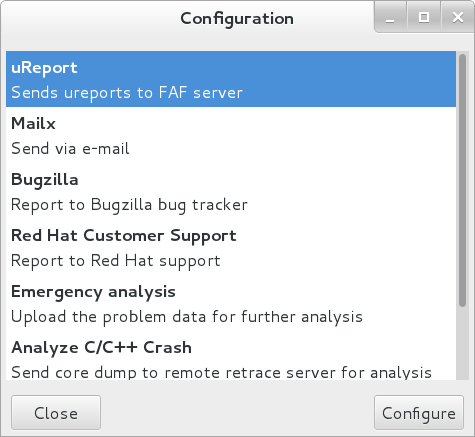

1.8. kdump 메커니즘을 사용하여 Crashed 커널 덤프

이 섹션에서는 kdump 라고도 하는 커널 크래시 덤프 메커니즘을 소개하고 1.8.1절. “사용할 수 있는 kdump Is 및 Which 작업” 에서 사용하는 kdump 를 간략하게 설명합니다.

kdump 서비스 활성화는 설치 프로세스의 일부이며, 설치 중에 kdump 가 기본적으로 활성화되었습니다. 이 섹션에서는 1.8.2절. “설치 프로세스 중 kdump 활성화 및 활성화” 에 설치하는 동안 kdump 를 활성화하는 방법과 1.8.3절. “설치 프로세스 후 kdump가 설치 및 활성화되었는지 확인” 의 설치 후 비활성화된 경우 kdump 서비스를 수동으로 활성화하는 방법에 대해 설명합니다.

웹 콘솔 을 사용하여 kdump 를 구성할 수도 있습니다. 자세한 내용은 1.8.4절. “웹 콘솔에서 kdump 구성”를 참조하십시오.

1.8.1. 사용할 수 있는 kdump Is 및 Which 작업

시스템 충돌의 경우 kdump 라는 커널 크래시 덤프 메커니즘을 사용하면 나중에 분석할 수 있도록 시스템 메모리의 내용을 저장할 수 있습니다. kdump 메커니즘은 kexec 시스템 호출을 사용합니다. 이 호출은 다른 커널의 컨텍스트에서 Linux 커널을 부팅하고, BIOS를 우회하고, 손실되는 첫 번째 커널 메모리의 내용을 보존하는 데 사용할 수 있습니다.

커널이 발생하면 kdump 는 kexec를 사용하여 두 번째 커널( capture kernel)으로 부팅합니다. 이 커널은 첫 번째 커널에 액세스할 수 없는 시스템 메모리의 예약된 부분에 있습니다. 두 번째 커널은 충돌한 커널의 메모리(감시 덤프)의 내용을 캡처하여 저장합니다.

1.8.2. 설치 프로세스 중 kdump 활성화 및 활성화

설치 중에 kdump 활성화 및 활성화는 Anaconda 설치 프로그램에서 수행하거나 Kickstart 파일에서 %addon com_redhat_kdump 명령을 사용하여 수행할 수 있습니다.

자세한 내용은 설치 방법에 따라 적절한 소스를 참조하십시오.

Anaconda 설치 프로그램으로 설치할 때 다음을 참조하십시오.

Red Hat Enterprise Linux 7 설치 가이드에서 Anaconda를 사용하여 설치.

Kickstart 파일로 설치하는 경우 다음을 참조하십시오.

Red Hat Enterprise Linux 7 설치 가이드의 Kickstart 명령 및 옵션.

1.8.3. 설치 프로세스 후 kdump가 설치 및 활성화되었는지 확인

kdump 가 설치되었는지 확인하고 구성하려면 다음을 수행합니다.

kdump 설치 및 kdump 구성 확인

kdump 가 시스템에 설치되어 있는지 확인하려면 다음을 수행하십시오.

rpm -q kexec-tools

~]$ rpm -q kexec-toolsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 설치되지 않은 경우 kdump 를 설치하려면

root사용자로 입력합니다.yum install kexec-tools

~]# yum install kexec-toolsCopy to Clipboard Copied! Toggle word wrap Toggle overflow kdump 를 구성하려면 다음을 수행합니다.

명령줄 또는 그래픽 사용자 인터페이스를 사용합니다.

두 옵션 모두 Red Hat Enterprise Linux 7 Kernel Crash Dump Guide에 자세히 설명되어 있습니다.

그래픽 구성 도구를 설치해야 하는 경우:

yum install system-config-kdump

~]# yum install system-config-kdumpCopy to Clipboard Copied! Toggle word wrap Toggle overflow

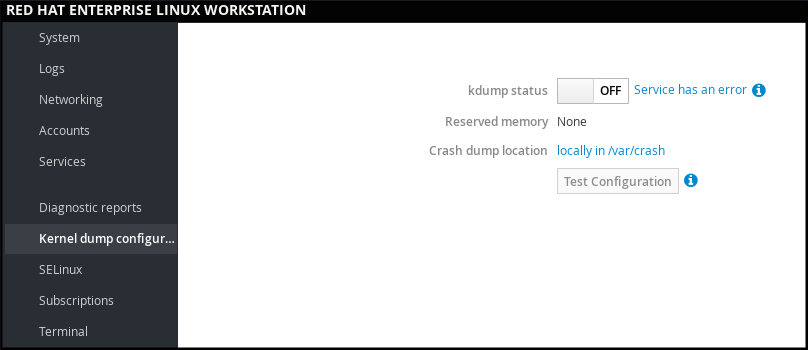

1.8.4. 웹 콘솔에서 kdump 구성

웹 콘솔에서 를 선택하여 확인합니다.

- kdump 상태

- kdump용으로 예약된 메모리 양

- 크래시 덤프 파일의 위치

그림 1.5. 웹 콘솔에서 kdump 구성

1.8.5. kdump의 추가 리소스

kdump 에 대한 자세한 내용은 Red Hat Enterprise Linux 7 Kernel Crash Dump Guide를 참조하십시오.

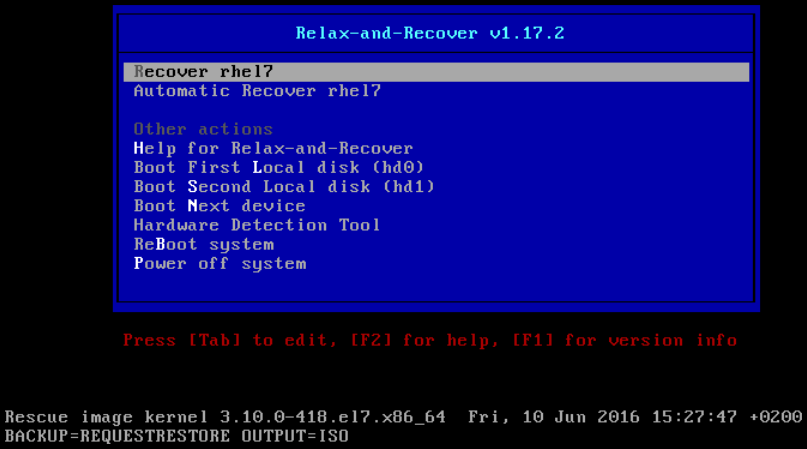

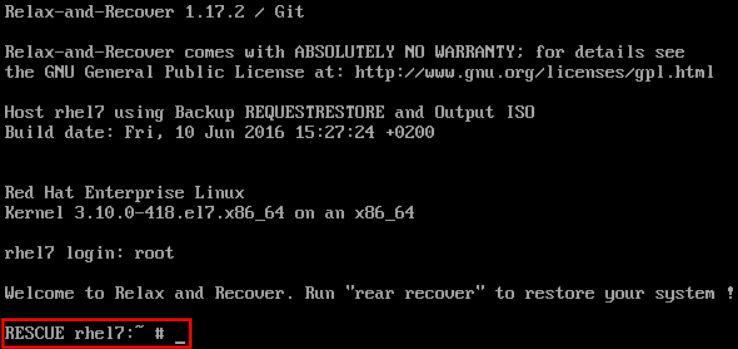

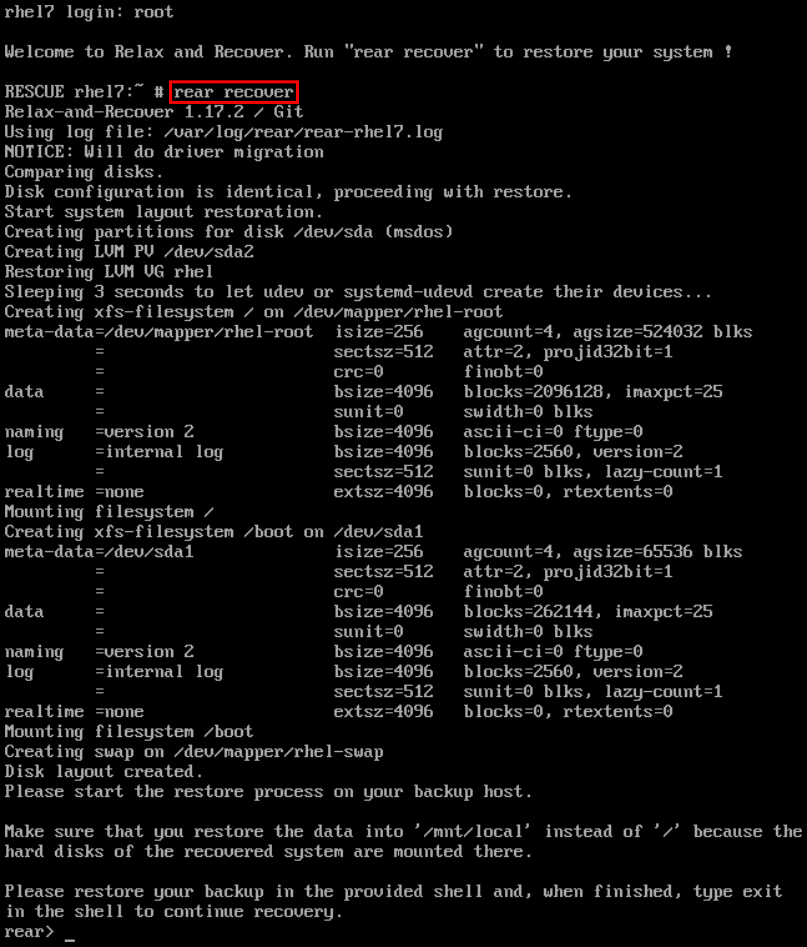

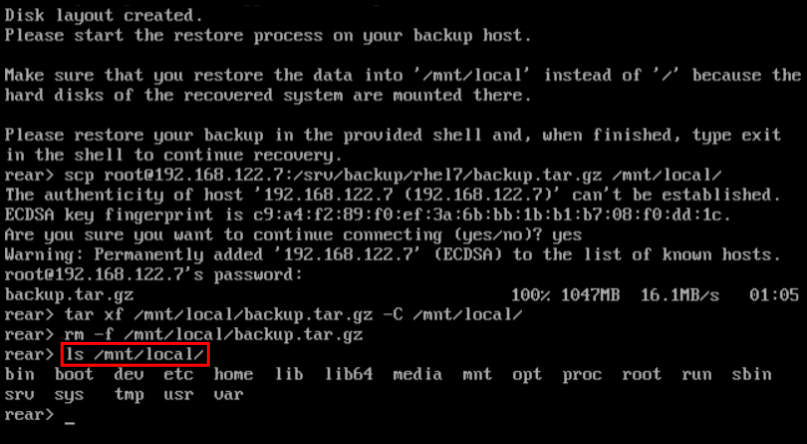

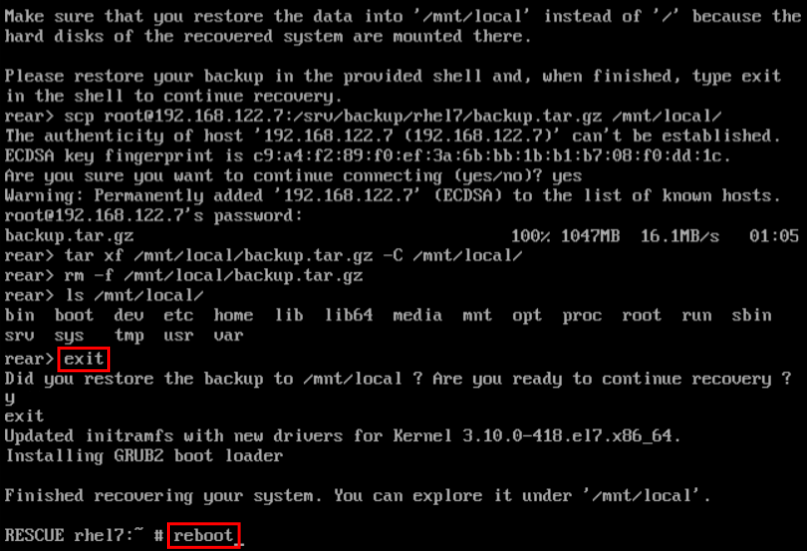

1.9. ReaR을 사용하여 시스템 복구 수행 및 시스템 백업 생성

소프트웨어 또는 하드웨어 장애가 운영 체제를 중단하면 시스템을 복구하기 위한 메커니즘이 필요합니다. 또한 시스템 백업을 저장해야 하는 것도 유용합니다. Red Hat은 Relax-and-Recover(ReaR) 도구를 사용하여 이러한 두 가지 요구 사항을 모두 충족할 것을 권장합니다.

1.9.1. ReaR Is 및 Which 작업은 사용할 수 있습니다.

Rear는 재해 복구 및 시스템 마이그레이션 유틸리티로 전체 복구 시스템을 만들 수 있습니다. 기본적으로 이 복구 시스템은 스토리지 레이아웃과 부트 로더만 복원하지만 실제 사용자 및 시스템 파일은 복원되지 않습니다.

또한 특정 백업 소프트웨어를 사용하면 재해 복구를 위해 ReaR을 통합할 수 있습니다.

을 다시 사용하여 다음 작업을 수행할 수 있습니다.

- 새 하드웨어에서 복구 시스템 부팅

- 원래 스토리지 레이아웃 복제

- 사용자 및 시스템 파일 복원

1.9.2. ReaR 설치 및 구성 빠른 시작

ReaR을 설치하려면 root 사용자로 를 입력합니다.

yum install rear

~]# yum install rear

/etc/rear/local.conf 파일의 설정을 사용하여 ReaR을 구성합니다.

자세한 내용은 27.1절. “기본 ReaR 사용” 에서 참조하십시오.

1.9.3. ReaR을 사용하여 복구 시스템 생성에 대한 빠른 시작

- 복구 시스템을 생성하려면

root사용자로 다음 명령을 실행하십시오.

rear mkrescue

~]# rear mkrescueReaR을 사용하여 구조 시스템 생성에 대한 자세한 내용은 27.1.3절. “복구 시스템 생성” 를 참조하십시오.

1.9.4. 백업 소프트웨어를 사용하여 ReaR 구성 빠른 시작

rear에는 NETFS라는 완전히 통합된 내장형 또는 내부 백업 방법이 포함되어 있습니다.

ReaR이 내부 백업 방법을 사용하도록 하려면 다음 행을 /etc/rear/local.conf 파일에 추가하십시오.

BACKUP=NETFS BACKUP_URL=backup location

BACKUP=NETFS

BACKUP_URL=backup location

/etc/rear/local.conf 에 다음 행을 추가하여 새 백업 아카이브를 만들 때 이전 백업 아카이브를 유지하도록 ReaR을 구성할 수도 있습니다.

NETFS_KEEP_OLD_BACKUP_COPY=y

NETFS_KEEP_OLD_BACKUP_COPY=y

백업을 증분적으로 만들려면 각 실행 시 변경된 파일만 백업됩니다. /etc/rear/local.conf 에 이 행을 추가합니다.

BACKUP_TYPE=incremental

BACKUP_TYPE=incrementalReaR NETFS 내부 백업 방법 사용에 대한 자세한 내용은 27.2.1절. “Built-in Backup 방법” 을 참조하십시오.

지원되는 외부 백업 방법 및 지원되지 않는 백업 방법에 대한 자세한 내용은 27.2.2절. “지원되는 백업 방법” 및 27.2.3절. “지원되지 않는 백업 방법” 을 참조하십시오.

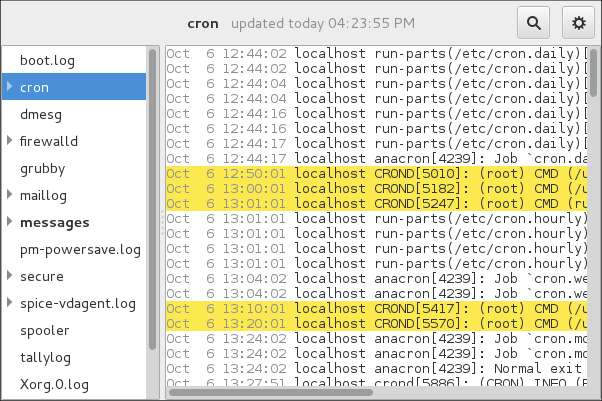

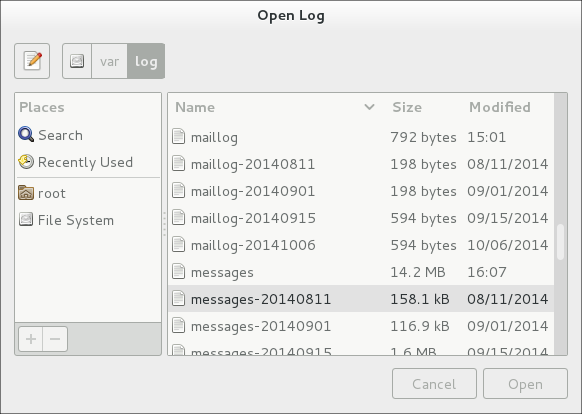

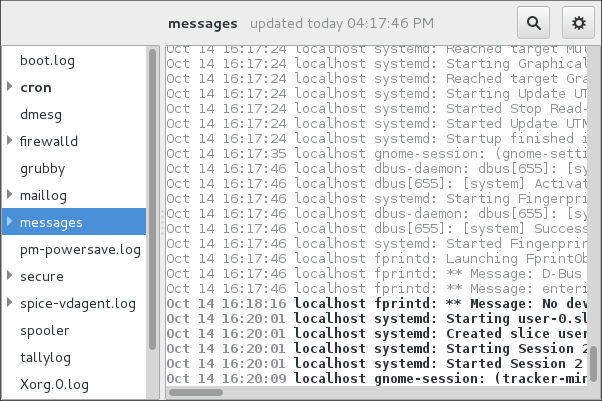

1.10. 로그 파일을 사용하여 문제 해결

문제를 해결할 때 운영 체제에 대한 다른 정보와 메시지가 포함된 로그 파일을 감사할 수 있습니다. Red Hat Enterprise Linux 7의 로깅 시스템은 내장 syslog 프로토콜을 기반으로 합니다. 특정 프로그램은 이 시스템을 사용하여 이벤트를 기록하고 이를 로그 파일로 구성하며 운영 체제를 감사하고 다양한 문제를 해결할 때 유용합니다.

로그 파일에 대한 자세한 내용은 23장. 로그 파일 보기 및 관리 을 참조하십시오.

1.10.1. services Handling the syslog messages

syslog 메시지는 두 서비스에서 처리됩니다.

-

systemd-journald데몬 - 커널에서 메시지 수집, 부팅 프로세스의 초기 단계, 데몬이 시작되어 실행될 때의 표준 출력 및 오류, syslog, 추가 처리를 위해 메시지를rsyslog서비스로 전달합니다. -

rsyslog서비스 - syslog 메시지를 유형 및 우선 순위에 따라 정렬하고/var/log디렉터리의 파일에 기록하며 로그가 지속적으로 저장됩니다.

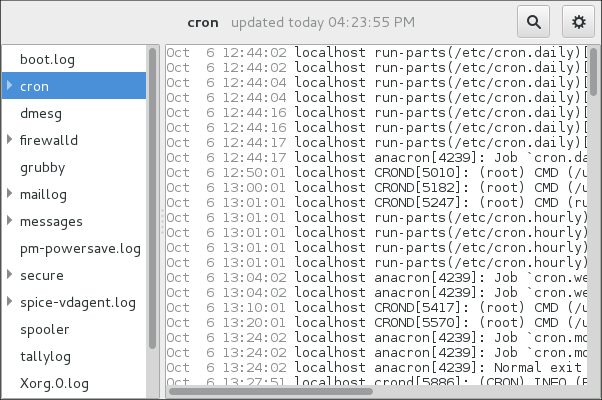

1.10.2. 하위 디렉터리 저장 syslog 메시지 저장

syslog 메시지는 포함된 메시지 및 로그에 따라 /var/log 디렉터리의 다양한 하위 디렉터리에 저장됩니다.

-

var/log/inspector- 아래에 언급된 syslog 메시지를 제외한 모든 syslog 메시지 -

var/log/secure- 보안 및 인증 관련 메시지 및 오류 -

var/log/maillog- 메일 서버 관련 메시지 및 오류 -

var/log/cron- 주기적으로 실행되는 작업과 관련된 로그 파일 -

var/log/boot.log- 시스템 시작과 관련된 로그 파일

1.11. Red Hat 지원 액세스

Red Hat의 지원을 받으려면 서브스크립션과 함께 제공되는 모든 항목에 액세스할 수 있는 Red Hat 고객 포털 을 사용하십시오.

이 섹션에서는 다음을 설명합니다.

- Red Hat 지원 받기 참조 1.11.1절. “Red Hat 고객 포털을 통해 Red Hat 지원 요청”

- SOS 보고서를 사용하여 문제 해결을 참조하십시오. 1.11.2절. “문제 해결을 위해 SOS 보고서 사용”

1.11.1. Red Hat 고객 포털을 통해 Red Hat 지원 요청

Red Hat 고객 포털 을 사용하면 다음을 수행할 수 있습니다.

- 새 지원 케이스 만들기

- Red Hat 전문가와의 실시간 채팅 시작

- 전화하거나 이메일을 보내 Red Hat 전문가에게 문의하십시오.

Red Hat 고객 포털에 액세스하려면 https://access.redhat.com 로 이동하십시오.

Red Hat 지원과 관련된 Red Hat 고객 포털 서비스를 사용하려면 다음을 사용할 수 있습니다.

- 웹 브라우저

- Red Hat 지원 도구

1.11.1.1. Red Hat 지원 도구 Is 및 Which 작업이란 무엇입니까?

Red Hat 지원 도구는 서브스크립션 기반 Red Hat 액세스 서비스에 대한 텍스트 콘솔 인터페이스를 제공하는 명령줄 기반 도구입니다. 이 툴은 redhat-support-tool 패키지에 포함되어 있습니다.

Red Hat 지원 도구를 사용하면 다음과 같은 지원 관련 작업을 수행할 수 있습니다.

- 지원 케이스 공개 또는 업데이트

- Red Hat 지식 기반 솔루션 검색

- Python 및 Java 오류 분석

대화형 모드에서 툴을 시작하려면 다음을 수행합니다.

redhat-support-tool Welcome to the Red Hat Support Tool. Command (? for help):

~]$ redhat-support-tool

Welcome to the Red Hat Support Tool.

Command (? for help):대화형 모드에서 ?를 사용 가능한 명령을 표시합니다.

Command (? for help): ?

Command (? for help): ?Red Hat 지원 툴 설치 및 사용에 대한 자세한 내용은 8장. Red Hat 지원 도구를 사용하여 지원에 액세스 및 Red Hat 지식베이스 문서 Red Hat Access를 참조하십시오. Red Hat 지원 도구.

1.11.2. 문제 해결을 위해 SOS 보고서 사용

SOS 보고서는 Red Hat Enterprise Linux 시스템에서 구성 세부 정보, 시스템 정보 및 진단 정보를 수집합니다. 지원 케이스를 열 때 보고서를 첨부합니다.

SOS 보고서는 Red Hat Enterprise Linux 7의 기본 최소 설치로 설치되지 않는 sos 패키지에 제공됩니다.

sos 패키지를 설치하려면 다음을 수행합니다.

yum install sos

~]# yum install sosSOS 보고서를 생성하려면 다음을 수행합니다.

sosreport

~]# sosreport지원 사례에 보고서를 첨부하려면 Red Hat 지식베이스 문서 How can I attach a file to a Red Hat 지원 케이스 에서 참조하십시오. sos 보고서를 연결할 때 지원 케이스 수를 입력하라는 메시지가 표시됩니다.

SOS 보고서에 대한 자세한 내용은 Red Hat 지식베이스 문서 What is a sosreport and how to create one in Red Hat Enterprise Linux 4.6 이상에서 참조하십시오.

2장. System Locale 및 keyboard Configuration

시스템 로케일 은 시스템 서비스 및 사용자 인터페이스의 언어 설정을 지정합니다. 키보드 레이아웃 설정은 텍스트 콘솔 및 그래픽 사용자 인터페이스에서 사용되는 레이아웃을 제어합니다.

이러한 설정은 /etc/locale.conf 구성 파일을 수정하거나 localectl 유틸리티를 사용하여 설정할 수 있습니다. 또한 그래픽 사용자 인터페이스를 사용하여 작업을 수행할 수 있습니다. 이 방법에 대한 설명은 Red Hat Enterprise Linux 7 설치 가이드 를 참조하십시오.

2.1. 시스템 위치 설정

시스템 전체 로케일 설정은 systemd 데몬에서 초기 부팅 시 읽는 /etc/locale.conf 파일에 저장됩니다. /etc/locale.conf 에 구성된 로케일 설정은 개별 프로그램 또는 개별 사용자가 재정의하지 않는 한 모든 서비스 또는 사용자에 의해 상속됩니다.

/etc/locale.conf 의 기본 파일 형식은 줄로 구분된 변수 할당 목록입니다. 예를 들어, /etc/locale.conf 에 영어 메시지가 있는 독일어 로케일은 다음과 같습니다.

LANG=de_DE.UTF-8 LC_MESSAGES=C

LANG=de_DE.UTF-8

LC_MESSAGES=C

여기에서 LC_MESSAGES 옵션은 표준 오류 출력에 기록된 진단 메시지에 사용되는 로케일을 결정합니다. /etc/locale.conf 에서 로케일 설정을 추가로 지정하려면 다른 여러 옵션을 사용할 수 있으므로 가장 관련된 옵션은 표 2.1. “/etc/locale.conf에서 설정 가능한 옵션” 에 요약되어 있습니다. 이러한 옵션에 대한 자세한 내용은 locale(7) 매뉴얼 페이지를 참조하십시오. 가능한 모든 옵션을 나타내는 LC_ALL 옵션은 /etc/locale.conf 에서 구성해서는 안 됩니다.

| 옵션 | 설명 |

|---|---|

| ANG | 시스템 로케일의 기본값을 제공합니다. |

| LC_COLLATE | 로컬 알파벳의 문자열을 비교하는 함수의 동작을 변경합니다.Changes the behavior of functions that compare strings in the local alphabet. |

| LC_CTYPE | 문자 처리 및 분류 함수 및 멀티바이트 문자 함수의 동작을 변경합니다.Changes the behavior of the character handling and classification functions and the multibyte character functions. |

| LC_NUMERIC | 소수점과 10진수 쉼표와 같은 세부 정보를 사용하여 숫자를 일반적으로 출력하는 방법을 설명합니다.Describes the way numbers are usually printed, with details such as decimal point and decimal comma. |

| LC_TIME | 현재 시간 표시를 24시간과 12시간로 변경합니다. |

| LC_MESSAGES | 표준 오류 출력에 기록된 진단 메시지에 사용되는 로케일을 결정합니다. |

2.1.1. 현재 상태 표시

localectl 명령을 사용하여 시스템 로케일 및 키보드 레이아웃 설정을 쿼리하고 변경할 수 있습니다. 현재 설정을 표시하려면 status 옵션을 사용합니다.

localectl status

localectl status예 2.1. 현재 상태 표시

이전 명령의 출력에는 현재 설정된 로케일과 콘솔에 구성된 키보드 레이아웃과 X11 창 시스템이 나열됩니다.

localectl status

System Locale: LANG=en_US.UTF-8

VC Keymap: us

X11 Layout: n/a

~]$ localectl status

System Locale: LANG=en_US.UTF-8

VC Keymap: us

X11 Layout: n/a2.1.2. 사용 가능한 로컬 나열

시스템에 사용 가능한 모든 로케일을 나열하려면 다음을 입력합니다.

localectl list-locales

localectl list-locales예 2.2. 로컬 나열

특정 영어 로케일을 선택한다고 가정하지만 시스템에서 사용할 수 있는지 확실하지 않습니다. 다음 명령으로 모든 영어 로케일을 나열하여 확인할 수 있습니다.

2.1.3. 로컬 설정

기본 시스템 로케일을 설정하려면 다음 명령을 root 로 사용하십시오.

localectl set-locale LANG=locale

localectl set-locale LANG=locale

locale 을 localectl list-locales 명령을 사용하여 찾은 로케일 이름으로 바꿉니다. 위의 구문을 사용하여 표 2.1. “/etc/locale.conf에서 설정 가능한 옵션” 에서 매개 변수를 구성할 수도 있습니다.

예 2.3. 기본 지역 변경

예를 들어, English English를 기본 로케일로 설정하려는 경우 먼저 list-locales 를 사용하여 이 로케일의 이름을 찾습니다. 그런 다음 루트 로서 다음 형식으로 명령을 입력합니다.

localectl set-locale LANG=en_GB.utf8

~]# localectl set-locale LANG=en_GB.utf82.1.4. Kickstart로 설치할 때 시스템 로컬 설정 허용

Red Hat Enterprise Linux를 Red Hat Kickstart 설치 방법을 사용하여 설치하는 경우 운영 체제를 업그레이드한 후에는 시스템 로케일 설정이 유지되지 않을 수 있습니다.

Kickstart 파일의 %packages 섹션에 --instLang 옵션이 포함된 경우 _install_langs RPM 매크로는 이 설치의 특정 값으로 설정되고 설치된 로케일 세트가 적절하게 조정됩니다. 그러나 이러한 조정은 후속 업그레이드가 아닌 이 설치에만 영향을 미칩니다. 업그레이드가 glibc 패키지를 다시 설치하는 경우 설치 중에 요청한 로케일 대신 전체 로케일 집합이 업그레이드됩니다.

이를 방지하려면 영구적으로 로캘을 선택합니다. 이러한 옵션이 있습니다.

- Kickstart 설치를 시작하지 않은 경우 다음 절차를 적용하여 전역적으로 RPM 매크로를 설정하는 지침을 포함하도록 Kickstart 파일을 수정하십시오. Kickstart 설치 중 RPM 매크로 설정

- 이미 시스템을 설치한 경우 다음 절차를 적용하여 시스템에서 RPM 매크로를 전역적으로 설정합니다. 전역적으로 RPM 매크로 설정

Kickstart 설치 중 RPM 매크로 설정

Kickstart 파일의

%post섹션을 수정합니다.LANG=en_US echo "%_install_langs $LANG" > /etc/rpm/macros.language-conf yum-config-manager --setopt=override_install_langs=$LANG --save

LANG=en_US echo "%_install_langs $LANG" > /etc/rpm/macros.language-conf yum-config-manager --setopt=override_install_langs=$LANG --saveCopy to Clipboard Copied! Toggle word wrap Toggle overflow Kickstart 파일의

%packages섹션을 수정합니다.%packages yum-utils* %end

%packages yum-utils* %endCopy to Clipboard Copied! Toggle word wrap Toggle overflow

전역적으로 RPM 매크로 설정

다음 콘텐츠를 사용하여

/etc/rpm/macros. language-conf에 RPM 구성 파일을 만듭니다.%_install_langs LANG

%_install_langs LANGCopy to Clipboard Copied! Toggle word wrap Toggle overflow LANG 는

instLang옵션의 값입니다./etc/yum.conf파일을 다음으로 업데이트합니다.override_install_langs=LANG

override_install_langs=LANGCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2. keyboard Layout 변경

키보드 레이아웃 설정을 사용하면 텍스트 콘솔 및 그래픽 사용자 인터페이스에서 사용되는 레이아웃을 제어할 수 있습니다.

2.2.1. 현재 설정 표시

이전에 언급했듯이 다음 명령을 사용하여 현재 키보드 레이아웃 구성을 확인할 수 있습니다.

localectl status

localectl status예 2.4. keyboard 설정 표시

다음 출력에서는 가상 콘솔과 X11 창 시스템에 대해 구성된 키보드 레이아웃을 확인할 수 있습니다.

localectl status

System Locale: LANG=en_US.utf8

VC Keymap: us

X11 Layout: us

~]$ localectl status

System Locale: LANG=en_US.utf8

VC Keymap: us

X11 Layout: us2.2.2. 사용 가능한 키 맵 나열

시스템에서 구성할 수 있는 사용 가능한 모든 키보드 레이아웃을 나열하려면 다음을 입력합니다.

localectl list-keymaps

localectl list-keymaps예 2.5. Particular Keymap 검색

grep 을 사용하여 이전 명령의 출력을 특정 키맵 이름으로 검색할 수 있습니다. 현재 설정된 로케일과 호환되는 여러 keymap이 종종 있습니다. 예를 들어 사용 가능한 체코 키보드 레이아웃을 찾으려면 다음을 입력합니다.

2.2.3. Keymap 설정

시스템의 기본 키보드 레이아웃을 설정하려면 root 로 다음 명령을 사용하십시오.

localectl set-keymap map

localectl set-keymap map

map 을 localectl list-keymaps 명령의 출력에서 가져온 keymap의 이름으로 바꿉니다. no -convert 옵션이 전달되지 않으면 선택한 설정이 X11 창 시스템의 기본 키보드 매핑에도 적용되며 X11 키보드 매핑은 가장 가까운 X11 키보드 매핑으로 변환됩니다. 이는 역방향에도 적용됩니다. root 로 다음 명령을 사용하여 두 keymaps를 지정할 수 있습니다.

localectl set-x11-keymap map

localectl set-x11-keymap map

X11 레이아웃이 콘솔 레이아웃과 다르도록 하려면 --no-convert 옵션을 사용합니다.

localectl --no-convert set-x11-keymap map

localectl --no-convert set-x11-keymap map이 옵션을 사용하면 이전 콘솔 레이아웃 설정을 변경하지 않고 X11 keymap을 지정합니다.

예 2.6. X11 Keymap 분리

그래픽 인터페이스에서 독일어 키보드 레이아웃을 사용하고 있다고 가정하지만 미국 키맵을 유지하려면 콘솔 작업을 사용합니다. 이 작업을 수행하려면 root 로 입력합니다.

localectl --no-convert set-x11-keymap de

~]# localectl --no-convert set-x11-keymap de그런 다음 현재 상태를 확인하여 설정이 성공했는지 확인할 수 있습니다.

localectl status

System Locale: LANG=de_DE.UTF-8

VC Keymap: us

X11 Layout: de

~]$ localectl status

System Locale: LANG=de_DE.UTF-8

VC Keymap: us

X11 Layout: de키보드 레이아웃 (맵) 외에도 세 가지 다른 옵션을 지정할 수 있습니다.

localectl set-x11-keymap map model variant options

localectl set-x11-keymap map model variant options

모델을 키보드 모델 이름, 변형 및 옵션으로 키보드 변형 및 옵션 구성 요소로 교체합니다. 이 구성 요소는 키보드 동작을 향상시키는 데 사용할 수 있습니다. 이러한 옵션은 기본적으로 설정되어 있지 않습니다. X11 모델, X11 Variant 및 X11 옵션에 대한 자세한 내용은 kbd(4) 도움말 페이지를 참조하십시오.

2.3. 추가 리소스

Red Hat Enterprise Linux에서 키보드 레이아웃을 구성하는 방법에 대한 자세한 내용은 아래 나열된 리소스를 참조하십시오.

설치된 문서

-

localectl(1) -localectl명령줄 유틸리티 문서의 도움말 페이지는 이 툴을 사용하여 시스템 로케일 및 키보드 레이아웃을 구성하는 방법을 설명합니다. -

loadkeys(1) -loadkeys명령의 도움말 페이지는 이 도구를 사용하여 가상 콘솔의 키보드 레이아웃을 변경하는 방법에 대한 자세한 정보를 제공합니다.

예를 들면 다음과 같습니다.

-

6장. 권한 확보

su및sudo명령을 사용하여 관리 권한을 얻는 방법에 대해 설명합니다. -

10장. systemd를 사용하여 서비스 관리

systemctl명령을 사용하여 시스템 서비스를 관리하는 방법에 대한systemd및 문서에 대한 자세한 정보를 제공합니다.

3장. 날짜 및 시간 구성

최신 운영 체제는 다음 두 가지 유형의 시계를 구분합니다.

- 실시간 클럭 (RTC)은 일반적으로 하드웨어 클럭 (일반적으로 시스템 보드의 통합 회로)으로 알려져 있으며 컴퓨터가 종료될 때 실행되는 운영 체제의 현재 상태와 완전히 독립적입니다.

- 커널에 의해 유지 관리되고 초기 값은 실시간 시계를 기반으로하는 시스템 클럭 (소프트웨어 클럭)입니다. 시스템이 부팅되고 시스템 시계가 초기화되면 시스템 클럭은 실시간 시계와 완전히 독립적입니다.

시스템 시간은 항상UTC( 협정 세계시 )로 유지되며 필요에 따라 애플리케이션에서 현지 시간으로 변환됩니다. 현지 시간은 일광 절약 시간 (DST)을 고려하여 현재 표준 시간대의 실제 시간입니다. 실시간 시계는 UTC 또는 현지 시간을 사용할 수 있습니다. UTC가 권장됩니다.

Red Hat Enterprise Linux 7은 시스템 날짜 및 시간에 대한 정보를 구성하고 표시하는 데 사용할 수 있는 세 가지 명령줄 툴을 제공합니다.

-

timedatectl유틸리티는 Red Hat Enterprise Linux 7의 새로운 기능이며systemd의 일부입니다. -

기존

date명령입니다. -

하드웨어 시계에 액세스하기 위한

hwclock유틸리티입니다.

3.1. timedatectl 명령 사용

timedatectl 유틸리티는 systemd 시스템 및 서비스 관리자의 일부로 배포되며 시스템 클럭의 구성을 검토하고 변경할 수 있습니다. 이 도구를 사용하여 현재 날짜와 시간을 변경하거나 시간대를 설정하거나 원격 서버와 시스템 클럭의 자동 동기화를 활성화할 수 있습니다.

현재 날짜 및 시간을 사용자 지정 형식으로 표시하는 방법에 대한 자세한 내용은 3.2절. “날짜 명령 사용” 도 참조하십시오.

3.1.1. 현재 날짜 및 시간 표시

시스템 및 하드웨어 시계 구성에 대한 자세한 정보와 함께 현재 날짜와 시간을 표시하려면 추가 명령줄 옵션 없이 timedatectl 명령을 실행합니다.

timedatectl

timedatectl

그러면 로컬 및 범용 시간, 현재 사용되는 표준 시간대,NTP(Network Time Protocol) 구성의 상태, DST와 관련된 추가 정보가 표시됩니다.

예 3.1. 현재 날짜 및 시간 표시

다음은 NTP 를 사용하여 시스템 클럭을 원격 서버와 동기화하는 시스템에서 timedatectl 명령의 출력 예입니다.

chrony 또는 ntpd 의 상태에 대한 변경 사항은 timedatectl 로 즉시 알 수 없습니다. 이러한 툴의 구성 또는 상태가 변경되면 다음 명령을 입력합니다.

systemctl restart systemd-timedated.service

~]# systemctl restart systemd-timedated.service3.1.2. 현재 시간 변경

현재 시간을 변경하려면 쉘 프롬프트에 root 로 다음을 입력합니다.

timedatectl set-time HH:MM:SS

timedatectl set-time HH:MM:SSHH 를 1시간, MM 을 1분으로 바꾸고, SS 를 1초로 바꾸면 모두 두 자리형으로 입력됩니다.

이 명령은 시스템 시간과 하드웨어 클럭을 모두 업데이트합니다. 그 결과 date --set 및 hwclock --systohc 명령을 모두 사용하는 것과 유사합니다.

NTP 서비스가 활성화되면 명령이 실패합니다. 서비스를 일시적으로 비활성화하려면 3.1.5절. “원격 서버와 시스템 Clock 동기화” 을 참조하십시오.

예 3.2. 현재 시간 변경

현재 시간을 11:26 p.m.로 변경하려면 root 로 다음 명령을 실행하십시오.

timedatectl set-time 23:26:00

~]# timedatectl set-time 23:26:00

기본적으로 시스템은 UTC를 사용하도록 구성됩니다. 로컬 시간에 클럭을 유지하도록 시스템을 구성하려면 set-local-rtc 옵션을 root 로 timedatectl 명령을 실행합니다.

timedatectl set-local-rtc boolean

timedatectl set-local-rtc boolean

로컬 시간에 클럭을 유지하도록 시스템을 구성하려면 부울 을 yes (또는, y,true,t 또는 1)로 바꿉니다. UTC를 사용하도록 시스템을 구성하려면 부울 을 no (또는, alternatively, n,false,f 또는 0)로 바꿉니다. 기본 옵션은 없습니다.

3.1.3. 현재 날짜 변경

현재 날짜를 변경하려면 쉘 프롬프트에 root 로 다음을 입력합니다.

timedatectl set-time YYYY-MM-DD

timedatectl set-time YYYY-MM-DDoctets을 4자리 연도로 바꾸고, MM 을 두 자리 월 한 달로, DD 를 월의 두 자리 날짜로 바꿉니다.

현재 시간을 지정하지 않고 날짜를 변경하면 시간을 00:00:00으로 설정합니다.

예 3.3. 현재 날짜 변경

현재 날짜를 2017년 6월 2일로 변경하고 현재 시간(11:26 p.m.)을 유지하려면 root 로 다음 명령을 실행합니다.

timedatectl set-time "2017-06-02 23:26:00"

~]# timedatectl set-time "2017-06-02 23:26:00"3.1.4. 시간대 변경

사용 가능한 모든 시간대를 나열하려면 쉘 프롬프트에서 다음을 입력합니다.

timedatectl list-timezones

timedatectl list-timezones

현재 사용된 시간대를 변경하려면 root 로 입력합니다.

timedatectl set-timezone time_zone

timedatectl set-timezone time_zone

time_zone 을 timedatectl list-timezones 명령으로 나열된 값으로 교체합니다.

예 3.4. 시간대 변경

현재 위치와 가장 가까운 시간대를 식별하려면 list-timezones 명령줄 옵션과 함께 timedatectl 명령을 사용합니다. 예를 들어 유럽의 사용 가능한 모든 시간대를 나열하려면 다음을 입력합니다.

시간대를 유럽/ 파그로 변경하려면 root 로 입력합니다.

timedatectl set-timezone Europe/Prague

~]# timedatectl set-timezone Europe/Prague3.1.5. 원격 서버와 시스템 Clock 동기화

이전 섹션에서 설명하는 수동 조정과 달리, timedatectl 명령을 사용하면 NTP 프로토콜을 사용하여 원격 서버 그룹과 시스템 클럭의 자동 동기화를 활성화할 수도 있습니다. NTP를 활성화하면 설치된 서비스에 따라 chronyd 또는 ntpd 서비스를 활성화합니다.

NTP 서비스는 다음과 같이 명령을 사용하여 활성화 및 비활성화할 수 있습니다.

timedatectl set-ntp boolean

timedatectl set-ntp boolean

시스템에서 시스템 클럭을 원격 NTP 서버와 동기화하도록 활성화하려면 부울 을 yes (기본값)로 교체합니다. 이 기능을 비활성화하려면 부울 을 no 로 바꿉니다.

예 3.5. 원격 서버와 시스템 Clock 동기화

원격 서버를 사용하여 시스템 클럭의 자동 동기화를 활성화하려면 다음을 입력합니다.

timedatectl set-ntp yes

~]# timedatectl set-ntp yes

NTP 서비스가 설치되지 않은 경우 명령이 실패합니다. 자세한 내용은 18.3.1절. “chrony 설치”를 참조하십시오.

3.2. 날짜 명령 사용

날짜 유틸리티는 모든 Linux 시스템에서 사용할 수 있으며 현재 날짜와 시간을 표시하고 구성할 수 있습니다. 스크립트가 사용자 지정 형식으로 시스템 시계에 대한 자세한 정보를 표시하는 데 자주 사용됩니다.

시간대를 변경하거나 원격 서버와 시스템 클럭의 자동 동기화를 활성화하는 방법에 대한 자세한 내용은 3.1절. “timedatectl 명령 사용” 을 참조하십시오.

3.2.1. 현재 날짜 및 시간 표시

현재 날짜 및 시간을 표시하려면 추가 명령줄 옵션 없이 date 명령을 실행합니다.

date

date그러면 요일, 현재 날짜, 현지 시간, 축약된 시간대 및 연도가 표시됩니다.

기본적으로 date 명령은 로컬 시간을 표시합니다. 시간을 UTC로 표시하려면 --utc 또는 -u 명령줄 옵션을 사용하여 명령을 실행합니다.

date --utc

date --utc

명령줄에서 +" 형식 " 옵션을 제공하여 표시되는 정보의형식 을 사용자 지정할 수도 있습니다.

date +"format"

date +"format"

형식은 예 3.6. “현재 날짜 및 시간 표시” 에 설명된 대로 하나 이상의 지원되는 제어 시퀀스로 바꿉니다. 이러한 옵션의 전체 목록은 표 3.1. “일반적으로 사용되는 제어 순서” 에서 가장 자주 사용되는 포맷 옵션 목록 또는 날짜(1) 매뉴얼 페이지를 참조하십시오.

| 제어 순서 | 설명 |

|---|---|

|

|

HH 형식의 시간(예: |

|

|

MM 형식의 분(예: |

|

|

두 번째는 SS 형식의 두 번째 형식(예: |

|

|

DD 형식의 월의 일(예: |

|

|

MM 형식의 월(예: |

|

|

octets 형식(예: |

|

|

표준 시간대 약어(예: |

|

|

전체 날짜 (예: |

|

|

HH:MM:SS 형식의 전체 시간(예: 17:30:24)입니다. 이 옵션은 |

예 3.6. 현재 날짜 및 시간 표시

현재 날짜 및 로컬 시간을 표시하려면 쉘 프롬프트에서 다음을 입력합니다.

date Mon Sep 16 17:30:24 CEST 2016

~]$ date

Mon Sep 16 17:30:24 CEST 2016현재 날짜 및 시간을 UTC로 표시하려면 쉘 프롬프트에서 다음을 입력합니다.

date --utc Mon Sep 16 15:30:34 UTC 2016

~]$ date --utc

Mon Sep 16 15:30:34 UTC 2016

date 명령의 출력을 사용자 지정하려면 다음을 입력합니다.

date +"%Y-%m-%d %H:%M" 2016-09-16 17:30

~]$ date +"%Y-%m-%d %H:%M"

2016-09-16 17:303.2.2. 현재 시간 변경

현재 시간을 변경하려면 --set 또는 -s 옵션과 함께 date 명령을 root 로 실행합니다.

date --set HH:MM:SS

date --set HH:MM:SSHH 를 1시간, MM 을 1분으로 바꾸고, SS 를 1초로 바꾸면 모두 두 자리형으로 입력됩니다.

기본적으로 date 명령은 시스템 클럭을 로컬 시간으로 설정합니다. UTC로 시스템 시계를 설정하려면 --utc 또는 -u 명령줄 옵션을 사용하여 명령을 실행합니다.

date --set HH:MM:SS --utc

date --set HH:MM:SS --utc예 3.7. 현재 시간 변경

현재 시간을 11:26 p.m.로 변경하려면 root 로 다음 명령을 실행하십시오.

date --set 23:26:00

~]# date --set 23:26:003.2.3. 현재 날짜 변경

현재 날짜를 변경하려면 --set 또는 -s 옵션과 함께 date 명령을 root 로 실행합니다.

date --set YYYY-MM-DD

date --set YYYY-MM-DDoctets을 4자리 연도로 바꾸고, MM 을 두 자리 월 한 달로, DD 를 월의 두 자리 날짜로 바꿉니다.

현재 시간을 지정하지 않고 날짜를 변경하면 시간을 00:00:00으로 설정합니다.

예 3.8. 현재 날짜 변경

현재 날짜를 2017년 6월 2일로 변경하고 현재 시간(11:26 p.m.)을 유지하려면 root 로 다음 명령을 실행합니다.

date --set "2017-06-02 23:26:00"

~]# date --set "2017-06-02 23:26:00"3.3. hwclock 명령 사용

H hwclock은 하드웨어 시계에 액세스하기 위한 유틸리티이며 RTC(Real Time Clock)라고도 합니다. 하드웨어 클럭은 사용하는 운영 체제와 독립적이며 머신이 종료된 경우에도 작동합니다. 이 유틸리티는 하드웨어 클럭에서 시간을 표시하는 데 사용됩니다. hwclock 에는 하드웨어 시계의 체계적인 변동을 보완하기 위한 시설도 포함되어 있습니다.

하드웨어 클럭은 연도, 월, 일, 시간, 분 및 초 값을 저장합니다. 시간 표준, 현지 시간 또는 UTC(협정 세계시)를 저장할 수 없으며 Daylight Saving Time(DST)을 설정할 수 없습니다.

hwclock 유틸리티는 /etc/adjtime 파일에 설정을 저장합니다. 예를 들어 시간을 수동으로 설정하거나 하드웨어 클럭을 시스템 시간과 동기화할 때 첫 번째 변경 사항을 사용하여 생성됩니다.

Red Hat Enterprise Linux 버전 6 및 7 간의 hwclock 동작 변경 사항은 Red Hat Enterprise Linux 7 마이그레이션 플래닝 가이드 를 참조하십시오.

3.3.1. 현재 날짜 및 시간 표시

root 사용자로 명령줄 옵션이 없는 hwclock 을 실행하면 로컬 시간으로의 날짜와 시간을 표준 출력으로 반환합니다.

hwclock

hwclock

hwclock 명령에 --utc 또는 --localtime 옵션을 사용하면 하드웨어 클럭 시간을 UTC 또는 현지 시간으로 표시하는 것은 아닙니다. 이러한 옵션은 하드웨어 시계를 설정하여 시간 중 하나를 유지하는 데 사용됩니다. 시간은 항상 현지 시간에 표시됩니다. 또한 hwclock --utc 또는 hwclock --local 명령을 사용하면 /etc/adjtime 파일의 레코드가 변경되지 않습니다. 이 명령은 /etc/adjtime 에 저장된 설정이 올바르지만 설정을 변경하지 않으려는 경우 유용할 수 있습니다. 반면 명령을 잘못된 방법으로 사용하면 잘못된 정보가 표시될 수 있습니다. 자세한 내용은 hwclock(8) 매뉴얼 페이지를 참조하십시오.

예 3.9. 현재 날짜 및 시간 표시

하드웨어 시계에서 현재 날짜와 현재 로컬 시간을 표시하려면 root 로 실행합니다.

hwclock Tue 15 Apr 2017 04:23:46 PM CEST -0.329272 seconds

~]# hwclock

Tue 15 Apr 2017 04:23:46 PM CEST -0.329272 secondsCEST는 표준 시간대 약어이며 Central Europe Summer Time을 의미합니다.

시간대를 변경하는 방법에 대한 자세한 내용은 3.1.4절. “시간대 변경” 을 참조하십시오.

3.3.2. 날짜 및 시간 설정

날짜 및 시간을 표시하는 것 외에도 하드웨어 시계를 특정 시간으로 수동으로 설정할 수 있습니다.

하드웨어 클럭 날짜와 시간을 변경해야 하는 경우 사양과 함께 --set 및 --date 옵션을 추가하여 이를 수행할 수 있습니다.

hwclock --set --date "dd mmm yyyy HH:MM"

hwclock --set --date "dd mmm yyyy HH:MM"dd 를 하루(두 자리 숫자)로, mmm 를 한 달(3자 약어), yyyy y를 1년(4자리 숫자)으로 바꿉니다. HH 는 1시간(두 자리 숫자)으로 MM 을 1분(두 자리 숫자)으로 바꿉니다.

동시에 --utc 또는 --localtime 옵션을 추가하여 시간을 UTC 또는 현지 시간으로 유지하도록 하드웨어 시계를 설정할 수도 있습니다. 이 경우 UTC 또는 LOCAL 이 /etc/adjtime 파일에 기록됩니다.

예 3.10. 하드웨어 시계를 특정 날짜 및 시간으로 설정

날짜 및 시간을 특정 값 (예: "21:17, 2016년 10월 21일)로 설정하고 하드웨어 시계를 UTC로 유지하려면 다음 형식으로 명령을 실행합니다.

hwclock --set --date "21 Oct 2016 21:17" --utc

~]# hwclock --set --date "21 Oct 2016 21:17" --utc3.3.3. 날짜 및 시간 동기화

하드웨어 클럭과 현재 시스템 시간을 두 방향으로 동기화할 수 있습니다.

다음 명령을 사용하여 하드웨어 시계를 현재 시스템 시간으로 설정할 수 있습니다.

hwclock --systohc

hwclock --systohcCopy to Clipboard Copied! Toggle word wrap Toggle overflow NTP를 사용하는 경우 하드웨어 클럭은 11분마다 시스템 클럭에 자동으로 동기화되며 이 명령은 적절한 초기 시스템 시간을 가져오는 데 부팅 시에만 유용합니다.

또는 다음 명령을 사용하여 하드웨어 클럭에서 시스템 시간을 설정할 수 있습니다.

hwclock --hctosys

hwclock --hctosysCopy to Clipboard Copied! Toggle word wrap Toggle overflow

하드웨어 클럭과 시스템 시간을 동기화할 때 --utc 또는 --localtime 옵션을 추가하여 하드웨어 시계를 로컬 시간 또는 UTC에 유지할지 여부를 지정할 수도 있습니다. --set,UTC 또는 LOCAL 을 사용하는 것과 유사하게 /etc/adjtime 파일에 기록됩니다.

hwclock --systohc --utc 명령은 timedatectl set-local-rtc false 와 기능적으로 유사하며, hwclock --systohc --local 명령은 timedatectl set-local-rtc true 의 대안입니다.

예 3.11. 시스템 시간과 하드웨어 시계 동기화

하드웨어 시계를 현재 시스템 시간으로 설정하고 하드웨어 시계를 로컬 시간에 유지하려면 다음 명령을 root 로 실행하십시오.

hwclock --systohc --localtime

~]# hwclock --systohc --localtime표준 시간대 및 DST 전환의 문제를 방지하려면 하드웨어 시계를 UTC로 유지하는 것이 좋습니다. 표시된 예 3.11. “시스템 시간과 하드웨어 시계 동기화” 은 예를 들어 기본적으로 하드웨어 클럭이 로컬 시간에 실행되는 것으로 가정하고 다른 모든 시스템은 로컬 시간을 사용하여 수용해야하는 Windows 시스템으로의 경우 유용합니다. 가상 시스템에도 필요할 수 있습니다. 호스트에서 제공하는 가상 하드웨어 시계가 로컬 시간에 실행되는 경우 게스트 시스템도 로컬 시간을 사용하도록 구성해야 합니다.

3.4. 추가 리소스

Red Hat Enterprise Linux 7에서 날짜 및 시간을 구성하는 방법에 대한 자세한 내용은 아래 나열된 리소스를 참조하십시오.

설치된 문서

-

timedatectl(1) - 이 도구를 사용하여 시스템 클럭 및 해당 설정을 쿼리하고 변경하는 방법에 대한timedatectl명령줄 유틸리티 문서입니다. -

date(1) -date명령의 도움말 페이지는 지원되는 명령줄 옵션의 전체 목록을 제공합니다. -

hwclock(8) -hwclock명령의 도움말 페이지는 지원되는 명령줄 옵션의 전체 목록을 제공합니다.

예를 들면 다음과 같습니다.

- 2장. System Locale 및 keyboard Configuration 키보드 레이아웃을 구성하는 방법

-

6장. 권한 확보

su및sudo명령을 사용하여 관리 권한을 얻는 방법에 대해 설명합니다. -

10장. systemd를 사용하여 서비스 관리

systemctl명령을 사용하여 시스템 서비스를 관리하는 방법에 대한 systemd 및 문서에 대한 자세한 정보를 제공합니다.

4장. 사용자 및 그룹 관리

사용자 및 그룹 제어는 Red Hat Enterprise Linux 시스템 관리의 핵심 요소입니다. 이 장에서는 그래픽 사용자 인터페이스 및 명령줄의 사용자와 그룹을 추가, 관리 및 삭제하는 방법을 설명하고, 그룹 디렉터리 만들기와 같은 고급 주제를 다룹니다.

4.1. 사용자 및 그룹 소개

사용자는 (물리적 사용자와 연결된 계정) 또는 특정 애플리케이션을 위해 존재하는 계정일 수 있지만, 그룹은 공통 목적을 위해 사용자를 다루는 논리적 표현입니다. 그룹 내의 사용자는 해당 그룹이 소유한 파일을 읽기, 쓰기 또는 실행할 수 있는 동일한 권한을 공유합니다.

각 사용자는 사용자 ID(UID)라는 고유한 숫자 ID 번호와 연결됩니다. 마찬가지로 각 그룹은 그룹 ID (GID)와 연결됩니다. 파일을 생성하는 사용자도 해당 파일의 소유자와 그룹 소유자입니다. 파일에는 소유자, 그룹 및 기타 모든 사용자에 대한 별도의 읽기, 쓰기, 실행 권한이 할당됩니다. 파일 소유자는 루트 에서만 변경할 수 있으며 사용자와 파일 소유자 모두 액세스 권한을 변경할 수 있습니다.

root

또한 Red Hat Enterprise Linux는 소유자 이외의 특정 사용자에 대한 권한을 허용하는 파일 및 디렉토리에 대해ACL( 액세스 제어 목록 )을 지원합니다. 이 기능에 대한 자세한 내용은 5장. 액세스 제어 목록 을 참조하십시오.

예약된 사용자 및 그룹 ID

Red Hat Enterprise Linux는 시스템 사용자 및 그룹에 대해 1000 미만의 사용자 및 그룹 ID를 예약합니다. 기본적으로 사용자 관리자 는 시스템 사용자를 표시하지 않습니다. 예약된 사용자 및 그룹 ID는 설정 패키지에 설명되어 있습니다. 문서를 보려면 다음 명령을 사용하십시오.

cat /usr/share/doc/setup*/uidgid

cat /usr/share/doc/setup*/uidgid

예약된 범위가 나중에 증가할 수 있으므로 아직 예약되지 않은 5,000에서 시작하는 ID를 할당하는 것이 좋습니다. 기본적으로 새 사용자에게 ID를 할당하도록 하려면 /etc/login.defs 파일에서 UID_MIN 및 GID_MIN 지시문을 변경합니다.

[file contents truncated] UID_MIN 5000 [file contents truncated] GID_MIN 5000 [file contents truncated]

[file contents truncated]

UID_MIN 5000

[file contents truncated]

GID_MIN 5000

[file contents truncated]

UID_MIN 및 GID_MIN 지시문을 변경하기 전에 생성된 사용자의 경우 UID는 여전히 기본값 1000에서 시작합니다.

5,000으로 시작하는 새 사용자 및 그룹 ID를 사용하더라도 1000개 이상의 시스템에 의해 예약된 ID를 확보하지 않는 것이 1000개의 제한을 유지하는 시스템과 충돌하지 않도록 하는 것이 좋습니다.

4.1.1. 사용자 개인 그룹

Red Hat Enterprise Linux는UPG( 사용자 개인 그룹 ) 체계를 사용하므로 UNIX 그룹을 보다 쉽게 관리할 수 있습니다. 새 사용자가 시스템에 추가될 때마다 사용자 개인 그룹이 생성됩니다. 이 명령은 생성된 사용자와 동일한 이름을 가지며, 해당 사용자는 사용자 개인 그룹의 유일한 멤버입니다.

사용자 개인 그룹을 사용하면 새로 생성된 파일 또는 디렉토리에 대한 기본 권한을 설정하여 해당 사용자의 사용자 및 그룹을 모두 파일 또는 디렉토리를 수정할 수 있습니다.

새로 생성된 파일 또는 디렉터리에 적용되는 권한을 permissions라고 결정하는 설정은 /etc/bashrc 파일에 구성됩니다. 일반적으로 UNIX 기반 시스템에서는 파일 또는 디렉토리를 생성한 사용자만 수정할 수 있는 permissions가 022 로 설정됩니다. 이 체계 하에서, 크리에이터 그룹의 멤버를 포함한 다른 모든 사용자는 수정할 수 없습니다. 그러나 UPG 스키마에서는 모든 사용자에게 고유한 개인 그룹이 있으므로 이 "그룹 보호"가 필요하지 않습니다. 자세한 내용은 4.3.5절. “프롬프트를 사용하여 새 파일에 대한 기본 권한 설정 ”를 참조하십시오.

모든 그룹 목록은 /etc/group 구성 파일에 저장됩니다.

4.1.2. 섀도우 암호

여러 사용자가 있는 환경에서는 shadow-utils 패키지에서 시스템 인증 파일의 보안을 강화할 수 있는 섀도우 암호를 사용하는 것이 매우 중요합니다. 이러한 이유로 설치 프로그램은 기본적으로 shadow 암호를 활성화합니다.

다음은 섀도우 암호가 UNIX 기반 시스템에 암호를 저장하는 기존 방법에 비해 다음과 같은 이점 목록입니다.

-

shadow 암호는 암호화된 암호 해시를 world-readable

/etc/passwd파일에서/etc/shadow로 이동하여 시스템 보안을 향상시킵니다.root사용자만 읽을 수 있습니다. - shadow 암호는 암호 변경에 대한 정보를 저장합니다.

-

shadow 암호를 사용하면

/etc/login.defs파일에 설정된 일부 보안 정책을 적용할 수 있습니다.

shadow-utils 패키지에서 제공하는 대부분의 유틸리티는 섀도우 암호 활성화 여부에 관계없이 제대로 작동합니다. 그러나 암호 변경 정보는 /etc/shadow 파일에만 저장되므로 먼저 섀도우 암호를 활성화하지 않고 일부 유틸리티 및 명령이 작동하지 않습니다.

-

chage유틸리티는 암호 사용 기간 매개 변수를 설정합니다. 자세한 내용은 Red Hat Enterprise Linux 7 보안 가이드의 암호 보안 섹션을 참조하십시오. -

/etc/group파일을 관리하는gpasswd유틸리티입니다. -

-e, --expiredate또는-f, --inactive옵션을 사용하는usermod명령. -

-e, --expiredate또는-f, --inactive옵션을 사용하는useradd명령.

4.2. 그래픽 환경에서 사용자 관리

Users 유틸리티를 사용하면 그래픽 사용자 인터페이스에서 로컬 사용자를 확인, 수정, 추가 및 삭제할 수 있습니다.

4.2.1. 사용자 설정 도구 사용

Super 키를 눌러 활동 개요를 입력하고 사용자를 입력한 다음 Enter 를 누릅니다. 사용자 설정 도구가 나타납니다. Super 키는 키보드와 기타 하드웨어에 따라 다양한 길잡이에 표시되지만 일반적으로 공간 표시줄의 왼쪽에 Windows 또는 Command 키로 나타납니다. 또는 화면 오른쪽 상단에 있는 사용자 이름을 클릭한 후 Settings 메뉴에서 Users 유틸리티를 열 수 있습니다.

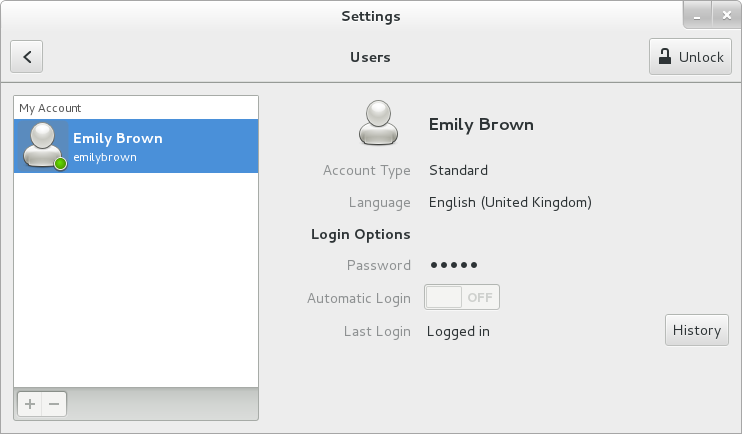

사용자 계정을 변경하려면 먼저 버튼을 선택하고 대화 상자가 표시된 대로 인증하십시오. 수퍼유저 권한이 없는 경우 애플리케이션은 root 로 인증하라는 메시지를 표시합니다. 사용자를 추가하고 제거하려면 각각 및 버튼을 선택합니다. 관리 그룹 wheel 에 사용자를 추가하려면 계정 유형을 Standard 에서 Administrator 로 변경합니다. 사용자 언어 설정을 편집하려면 언어 및 드롭다운 메뉴가 표시됩니다.

그림 4.1. 사용자 설정 도구

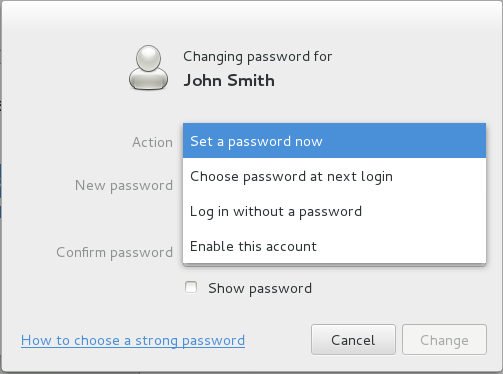

새 사용자가 생성되면 암호가 설정될 때까지 계정이 비활성화됩니다. 그림 4.2. “비밀번호 메뉴” 에 표시된 암호 드롭다운 메뉴에는 관리자가 즉시 암호를 설정하거나, 처음 로그인할 때 사용자가 암호를 선택하거나, 로그인에 필요한 암호 없이 게스트 계정을 생성합니다. 이 메뉴에서 계정을 비활성화하거나 활성화할 수도 있습니다.

그림 4.2. 비밀번호 메뉴

4.3. 명령줄 툴 사용

4.2절. “그래픽 환경에서 사용자 관리” 에 설명된 사용자 설정 도구 외에도 표 4.1. “사용자 및 그룹을 관리하기 위한 명령줄 유틸리티” 에 설명된 사용자 및 그룹 관리를 위해 명령줄 툴을 사용할 수 있습니다.

| 유틸리티 | 설명 |

|---|---|

|

| 사용자 및 그룹 ID를 표시합니다. |

|

| 사용자 계정을 추가, 수정 및 삭제하는 표준 유틸리티입니다. |

|

| 그룹을 추가, 수정 및 삭제하는 표준 유틸리티입니다. |

|

|

유틸리티는 주로 |

|

| 암호, 그룹 및 관련 shadow 파일을 확인하는 데 사용할 수 있는 유틸리티입니다. |

|

| 암호를 섀도우 암호로 변환하거나 섀도 암호에서 표준 암호로 전환하는 데 사용할 수 있는 유틸리티입니다. |

|

| 이전과 유사하게 이러한 유틸리티를 사용하여 그룹 계정에 대한 shadowed 정보를 변환할 수 있습니다. |

4.3.1. 새 사용자 추가

새 사용자를 시스템에 추가하려면 쉘 프롬프트에서 root 로 다음을 입력합니다.

useradd options username

useradd options username여기서 옵션 은 표 4.2. “일반 useradd 명령줄 옵션” 에 설명된 대로 명령줄 옵션입니다.

기본적으로 useradd 명령은 잠긴 사용자 계정을 생성합니다. 계정 잠금을 해제하려면 root 로 다음 명령을 실행하여 암호를 할당합니다.

passwd username

passwd username필요한 경우 암호 사용 기간 정책을 설정할 수 있습니다. Red Hat Enterprise Linux 7 보안 가이드의 암호 보안 섹션을 참조하십시오.

| 옵션 | |

|---|---|

|

| 주석은 임의의 문자열로 교체할 수 있습니다. 이 옵션은 일반적으로 사용자의 전체 이름을 지정하는 데 사용됩니다. |

|

|

기본 |

|

| octets-MM-DD 형식으로 계정을 비활성화하는 날짜입니다. |

|

|

암호가 만료된 후 계정이 비활성화될 때까지 일 수입니다. |

|

| 사용자 default( primary) 그룹의 그룹 이름 또는 그룹 번호입니다. 그룹은 여기에 지정되기 전에 존재해야 합니다. |

|

| 사용자가 멤버인 쉼표로 구분된 추가(기본값 이외의) 그룹 이름 또는 그룹 번호 목록입니다. 그룹은 여기에 지정되기 전에 존재해야 합니다. |

|

| 홈 디렉터리가 없는 경우 해당 디렉터리를 생성합니다. |

|

| 홈 디렉터리를 생성하지 마십시오. |

|

| 사용자에 대한 사용자 개인 그룹을 생성하지 마십시오. |

|

|

|

|

| 홈 디렉터리없이 1000 미만의 UID가 있는 시스템 계정을 생성합니다. |

|

|

기본값은 |

|

| 사용자의 사용자 ID는 unique이고 unique여야 합니다. |

시스템 및 일반 사용자의 기본 ID 범위는 Red Hat Enterprise Linux 7에서 이전 릴리스에서 변경되었습니다. 이전에는 일반 사용자에 대해 위의 시스템 사용자 및 값에 UID 1-499가 사용되었습니다. 시스템 사용자의 기본 범위는 이제 1-999입니다. 이러한 변경으로 인해 기존 사용자가 500~900 사이의 UID와 GID가 있는 Red Hat Enterprise Linux 7로 마이그레이션할 때 문제가 발생할 수 있습니다. UID 및 GID의 기본 범위는 /etc/login.defs 파일에서 변경할 수 있습니다.

프로세스 설명

다음 단계는 useradd juan 명령이 섀도가 활성화된 시스템에서 실행된 경우 어떤 일이 발생하는지를 보여줍니다.

/etc/passwd에

대한새 행이/etc/passwd에 생성됩니다.juan:x:1001:1001::/home/juan:/bin/bash

juan:x:1001:1001::/home/juan:/bin/bashCopy to Clipboard Copied! Toggle word wrap Toggle overflow 라인에는 다음과 같은 특징이 있습니다.

-

사용자 이름으로

시작합니다. -

시스템에서 섀도우 암호를 사용하고 있음을 나타내는

x(암호) 필드에는 x가 있습니다. - 6443보다 큰 UID가 생성됩니다. Red Hat Enterprise Linux 7에서 1000 미만의 UID는 시스템 사용을 위해 예약되어 있으며 사용자에게 할당해서는 안 됩니다.

- 6443보다 큰 GID가 생성됩니다. Red Hat Enterprise Linux 7에서 1000 미만의 GID는 시스템 사용을 위해 예약되어 있으며 사용자에게 할당해서는 안 됩니다.

- 선택적 GECOS 정보는 비어 있습니다. GECOS 필드는 사용자의 전체 이름 또는 전화 번호와 같은 추가 정보를 제공하는 데 사용할 수 있습니다.

-

juan의 홈 디렉토리는/home/juan/로 설정됩니다. -

기본 쉘은

/bin/bash로 설정됩니다.

-

사용자 이름으로

/etc/shadow에

대한새 행이/etc/shadow에 생성됩니다.juan:!!:14798:0:99999:7:::

juan:!!:14798:0:99999:7:::Copy to Clipboard Copied! Toggle word wrap Toggle overflow 라인에는 다음과 같은 특징이 있습니다.

-

사용자 이름으로

시작합니다. 두 개의 느낌표(

!!)가 계정을 잠그는/etc/shadow파일의 password 필드에 나타납니다.참고암호화된 암호가

-p플래그를 사용하여 전달되면 사용자의 새 줄의/etc/shadow파일에 배치됩니다.- 암호는 만료되지 않음으로 설정됩니다.

-

사용자 이름으로

jan이라는 그룹의 새 행이

/etc/group에 생성됩니다.juan:x:1001:

juan:x:1001:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 사용자와 동일한 이름을 가진 그룹을 사용자 개인 그룹 이라고 합니다. 사용자 개인 그룹에 대한 자세한 내용은 4.1.1절. “사용자 개인 그룹” 을 참조하십시오.

/etc/group에서 생성된 행은 다음과 같은 특징이 있습니다.-

그룹 이름으로

시작합니다. -

시스템이 섀도우 그룹 암호를 사용하고 있음을 나타내는

x가 password 필드에 나타납니다. -

GID는

/etc/passwd에 있는juan의 기본 그룹에 대해 나열된 항목과 일치합니다.

-

그룹 이름으로

jan이라는 그룹의 새 행이

/etc/gshadow에 생성됩니다.juan:!::

juan:!::Copy to Clipboard Copied! Toggle word wrap Toggle overflow 라인에는 다음과 같은 특징이 있습니다.

-

그룹 이름으로

시작합니다. -

느낌표(!

/etc/gshadow파일의 password 필드에 나타납니다. - 다른 모든 필드는 비어 있습니다.

-

그룹 이름으로

/home디렉토리에 사용자juan의 디렉터리가 생성됩니다.ls -ld /home/juan drwx------. 4 juan juan 4096 Mar 3 18:23 /home/juan

~]# ls -ld /home/juan drwx------. 4 juan juan 4096 Mar 3 18:23 /home/juanCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 디렉토리는 사용자

juan및 groupjuan이 소유합니다. 이 명령은 사용자(Jenan)에 대해서만 읽기,쓰기, 실행 권한을보유합니다. 기타 모든 권한은 거부됩니다./etc/skel/디렉터리 내의 파일(기본 사용자 설정이 포함된)은 새/home/juan/디렉토리에 복사됩니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

이 시점에서 'Udan'이라는 잠긴 계정이 시스템에 있습니다. 이를 활성화하려면 다음으로는 passwd 명령을 사용하여 계정에 암호를 할당하고 선택적으로 암호 사용 지침을 설정합니다(자세한 내용은 Red Hat Enterprise Linux 7 보안 가이드의 암호 보안 섹션 참조).

4.3.2. 새 그룹 추가

새 그룹을 시스템에 추가하려면 쉘 프롬프트에서 root 로 다음을 입력합니다.

groupadd options group_name

groupadd options group_name여기서 옵션 은 표 4.3. “공통 groupadd 명령줄 옵션” 에 설명된 대로 명령줄 옵션입니다.

| 옵션 | 설명 |

|---|---|

|

|

|

|

| 그룹의 그룹 ID는 unique이고 unique여야 합니다. |

|

|

|

|

| 중복된 GID를 사용하여 그룹을 생성할 수 있습니다. |

|

| 이 암호화된 암호를 새 그룹에 사용합니다. |

|

| GID가 1000 미만인 시스템 그룹을 만듭니다. |

4.3.3. 기존 그룹에 기존 사용자 추가

usermod 유틸리티를 사용하여 기존 사용자를 기존 그룹에 추가합니다.

usermod 의 다양한 옵션은 사용자의 기본 그룹과 해당 보조 그룹에 다른 영향을 미칩니다.

사용자의 기본 그룹을 재정의하려면 root 로 다음 명령을 실행합니다.

usermod -g group_name user_name

~]# usermod -g group_name user_name

사용자의 보조 그룹을 재정의하려면 root 로 다음 명령을 실행합니다.

usermod -G group_name1,group_name2,... user_name

~]# usermod -G group_name1,group_name2,... user_name이 경우 사용자의 이전의 모든 보조 그룹이 새 그룹 또는 여러 개의 새 그룹으로 교체됩니다.

사용자 보조 그룹에 하나 이상의 그룹을 추가하려면 root 로 다음 명령 중 하나를 실행합니다.

usermod -aG group_name1,group_name2,... user_name

~]# usermod -aG group_name1,group_name2,... user_nameusermod --append -G group_name1,group_name2,... user_name

~]# usermod --append -G group_name1,group_name2,... user_name이 경우 새 그룹이 사용자의 현재 보조 그룹에 추가됩니다.

4.3.4. 그룹 디렉터리 생성

시스템 관리자는 일반적으로 각 주요 프로젝트에 대한 그룹을 만들고 해당 프로젝트의 파일에 액세스해야 할 때 그룹에 사용자를 할당하는 것을 선호합니다. 이 기존 스키마를 사용하면 파일 관리가 어렵습니다. 사용자가 파일을 만들 때 해당 파일이 속한 기본 그룹과 연결됩니다. 한 사람이 여러 프로젝트에서 작업하면 올바른 파일을 올바른 그룹과 연결하는 것이 어려워집니다. 그러나 UPG 스키마를 사용하면 groups가 setgid 비트가 설정된 디렉터리 내에 생성된 파일에 자동으로 할당됩니다. setgid 비트는 디렉터리 내에 있는 사용자가 디렉터리를 소유한 그룹이 소유하므로 공통 디렉터리를 공유하는 그룹 프로젝트를 매우 간단하게 관리할 수 있습니다.

예를 들어, 사용자 그룹은 /opt/myproject/ 디렉토리의 파일에서 작업해야 합니다. 일부 사용자는 이 디렉터리의 내용을 수정할 수 있지만 모든 사람이 수정할 수는 없습니다.

루트로서 쉘 프롬프트에서 다음을 입력하여/opt/myproject/디렉터리를 만듭니다.mkdir /opt/myproject

mkdir /opt/myprojectCopy to Clipboard Copied! Toggle word wrap Toggle overflow myproject그룹을 시스템에 추가합니다.groupadd myproject

groupadd myprojectCopy to Clipboard Copied! Toggle word wrap Toggle overflow /opt/myproject/디렉터리의 콘텐츠를myproject그룹과 연결합니다.chown root:myproject /opt/myproject

chown root:myproject /opt/myprojectCopy to Clipboard Copied! Toggle word wrap Toggle overflow 그룹의 사용자가 디렉터리 내에 파일을 생성하고 setgid 비트를 설정할 수 있도록 허용합니다.

chmod 2775 /opt/myproject

chmod 2775 /opt/myprojectCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 시점에서

myproject그룹의 모든 멤버는 사용자가 새 파일을 쓸 때마다 파일 권한을 변경하지 않고도/opt/myproject/디렉토리에서 파일을 만들고 편집할 수 있습니다. 권한이 올바르게 설정되었는지 확인하려면 다음 명령을 실행합니다.ls -ld /opt/myproject drwxrwsr-x. 3 root myproject 4096 Mar 3 18:31 /opt/myproject

~]# ls -ld /opt/myproject drwxrwsr-x. 3 root myproject 4096 Mar 3 18:31 /opt/myprojectCopy to Clipboard Copied! Toggle word wrap Toggle overflow myproject그룹에 사용자를 추가합니다.usermod -aG myproject username

usermod -aG myproject usernameCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3.5. 프롬프트를 사용하여 새 파일에 대한 기본 권한 설정

프로세스에서 파일을 생성할 때 파일에는 특정 기본 권한(예: -rw-rw-r-- )이 있습니다. 이러한 초기 권한은 파일 권한 마스크 또는 umask 라고도 하는 파일 모드 생성 마스크 로 부분적으로 정의됩니다. 예를 들어, bash 에는 기본적으로 모든 프로세스에 자체 imagestreamtag 가 있습니다. 프로세스 imagestreamtag 는 변경될 수 있습니다.

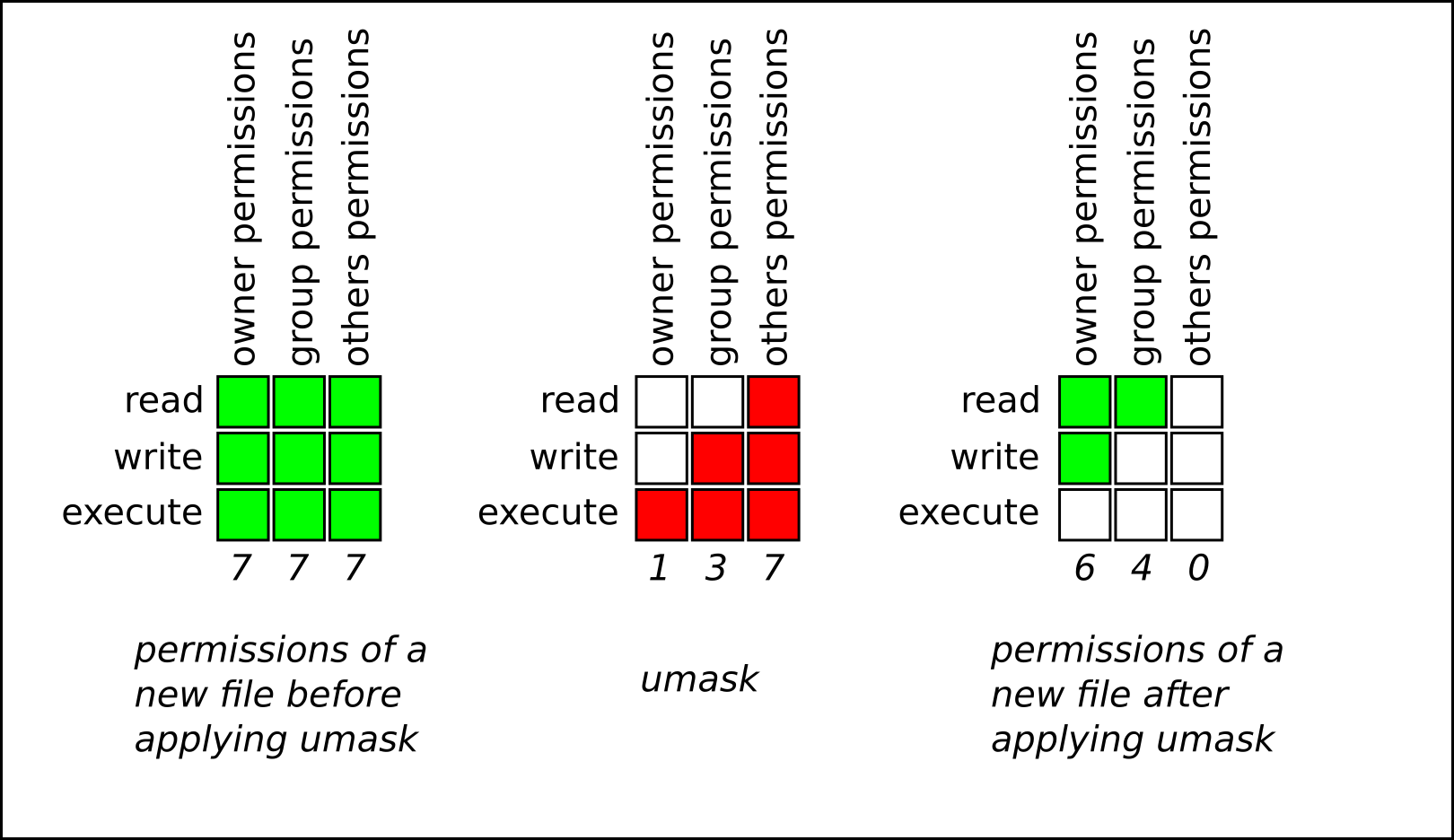

다음로 구성된 imagestreamtag

jaeger 는 표준 파일 권한에 해당하는 비트로 구성됩니다. 예를 들어 dependencies 0 137 의 경우 숫자는 다음과 같습니다.

-

0= no meaning, it is always0(umask does not affect special bits) -

1= 소유자 권한의 경우 실행 비트가 설정됩니다. -

3= 그룹 권한의 경우 실행 및 쓰기 비트가 설정됩니다. -

7= 기타 권한의 경우 실행, 쓰기 및 읽기 비트가 설정됩니다.

U마스크는 바이너리, 8진수 또는 심볼릭 표기법으로 표현할 수 있습니다. 예를 들어 8진수 표현 0137 은 심볼릭 표현 u=rw-,g=r-,o=-- 입니다. 기호 표기법 사양은 8진수 표기법 사양과 반대됩니다. 금지된 권한이 아니라 허용되는 권한이 표시됩니다.

imagestreamtag 작동 방식

jaeger 는 파일에 대한 권한을 설정하지 못하도록 합니다.

- syslog에 비트가 설정되어 있으면 파일에 설정되지 않습니다.

- messages에 비트가 설정되지 않은 경우 다른 요인에 따라 파일에서 설정할 수 있습니다.

다음 그림은 alerts 0137 이 새 파일 생성에 미치는 영향을 보여줍니다.

그림 4.3. 파일을 생성할 때 alerts 적용

보안상의 이유로 일반 파일은 기본적으로 실행 권한을 가질 수 없습니다. 따라서 credentials 가 권한을 금지하지 않는 0000 이지만 새 일반 파일에는 여전히 실행 권한이 없습니다. 그러나 실행 권한을 사용하여 디렉터리를 생성할 수 있습니다.

4.3.5.1. 쉘에서 imagestreamtag 관리

bash,ksh,zsh 및 tcsh 와 같은 인기 있는 쉘의 경우 umask 쉘 내장. 쉘에서 시작된 프로세스는 dependencies를 상속합니다.

현재 마스크를 표시

현재 umask 를 8진수 표기법으로 표시하려면 다음을 수행합니다.

umask 0022

~]$ umask

0022현재 mTLS를 심볼릭 표기법으로 표시하려면 다음을 수행합니다.

umask -S u=rwx,g=rx,o=rx

~]$ umask -S

u=rwx,g=rx,o=rxsyslog를 사용하여 쉘에 마스크 설정

8진수 표기법을 사용하여 현재 쉘 세션에 대해 mTLS를 설정하려면 다음을 실행합니다.

umask octal_mask

~]$ umask octal_mask

8 진수_마스크 를 0 에서 7 까지 4자리 이하로 대체합니다. 세 자리 이하가 제공되면 명령에 선행 0이 포함된 것처럼 권한이 설정됩니다. 예를 들어, dependencies 7 은 0007 로 변환됩니다.

예 4.1. 10월al Notation을 사용하여 imagestreamtag 설정

새 파일에 소유자 및 그룹에 대한 쓰기 및 실행 권한이 없도록 하고 다른 사용자에 대한 권한이 없도록 하려면 다음을 수행합니다.

umask 0337

~]$ umask 0337또는 간단히:

umask 337

~]$ umask 337심볼릭 표기법을 사용하여 현재 쉘 세션에 대해 mTLS를 설정하려면 다음을 수행합니다.

umask -S symbolic_mask

~]$ umask -S symbolic_mask예 4.2. Symbolic Notation을 사용하여 receiver 설정

심볼릭 표기법을 사용하여 receiver 0337 을 설정하려면 다음을 수행합니다.

umask -S u=r,g=r,o=

~]$ umask -S u=r,g=r,o=기본 쉘 dependencies로 작업

쉘에는 일반적으로 기본 mTLS가 설정된 설정 파일이 있습니다. bash 의 경우 /etc/bashrc 입니다. 기본 bash umask를 표시하려면 다음을 수행합니다.

grep -i -B 1 umask /etc/bashrc

~]$ grep -i -B 1 umask /etc/bashrc

출력 결과에서 dependencies 명령 또는 UMASK 변수를 사용하는 경우 output이 표시됩니다. 다음 예에서 umask 는 permissions 명령을 사용하여 022 로 설정됩니다.

bash 에 대한 기본 umask 를 변경하려면 /etc/bashrc.org에서 permissions 명령 호출 또는 UMASK 변수 할당을 변경합니다. 이 예에서는 기본 umask 를 0227 로 변경합니다.

if [ $UID -gt 199 ] && [ “id -gn” = “id -un” ]; then

umask 002

else

umask 227

if [ $UID -gt 199 ] && [ “id -gn” = “id -un” ]; then

umask 002

else

umask 227특정 사용자의 기본 쉘 messages로 작업

기본적으로 새 사용자의 bash umask 는 /etc/bashrc 에 정의된 기본값으로 설정됩니다.

특정 사용자에 대해 bash umask 를 변경하려면 해당 사용자의 $HOME/.bashrc 파일에 있는 dependencies 명령에 대한 호출을 추가합니다. 예를 들어 사용자 john 의 bash umask 를 0227 로 변경하려면 다음을 수행합니다.

john@server ~]$ echo 'umask 227' >> /home/john/.bashrc

john@server ~]$ echo 'umask 227' >> /home/john/.bashrc새로 생성된 홈 디렉터리에 대한 기본 권한 설정

생성된 사용자 홈 디렉터리의 권한을 변경하려면 /etc/login.defs 파일에서 UMASK 변수를 변경합니다.

# The permission mask is initialized to this value. If not specified, # the permission mask will be initialized to 022. UMASK 077

# The permission mask is initialized to this value. If not specified,

# the permission mask will be initialized to 022.

UMASK 0774.4. 추가 리소스

Red Hat Enterprise Linux에서 사용자 및 그룹을 관리하는 방법에 대한 자세한 내용은 아래 나열된 리소스를 참조하십시오.

설치된 문서

사용자 및 그룹 관리를 위한 다양한 유틸리티에 대한 자세한 내용은 다음 매뉴얼 페이지를 참조하십시오.

-

useradd(8) -useradd명령 문서의 수동 페이지에서 새 사용자를 만드는 방법을 설명합니다. -

userdel(8) -userdel명령의 수동 페이지는 사용자를 삭제하는 데 사용하는 방법에 대해 설명합니다. -

usermod(8) -usermod명령의 도움말 페이지에서 사용자를 수정하는 방법을 설명합니다. -

groupadd(8) -groupadd명령 문서의 도움말 페이지에서 새 그룹을 생성하는 방법을 설명합니다. -

groupdel(8) -groupdel명령의 도움말 페이지에서 그룹을 삭제하는 방법을 설명합니다. -

groupmod(8) -groupmod명령의 도움말 페이지에서 그룹 멤버십을 수정하는 방법을 설명합니다. -

gpasswd(1) -gpasswd명령 문서의 수동 페이지/etc/group파일 관리 방법입니다. -

grpck(8) -grpck명령의 수동 페이지 사용 방법을 사용하여/etc/group파일의 무결성을 확인합니다. -

pwck(8) -pwck명령의 수동 페이지는 이를 사용하여/etc/passwd및/etc/shadow파일의 무결성을 확인하는 방법을 설명합니다. -

pwconvpwunconv,grpconv,grpunconv명령의 수동 페이지, 암호 및 그룹의 섀도우 정보를 변환하는 방법을 설명합니다. -

ID (1) -

id -

imagestreamtag(2) - 파일 모드 생성 마스크를 사용하는 방법에 대한 permissions 명령의 수동 페이지입니다.

관련 구성 파일에 대한 자세한 내용은 다음을 참조하십시오.

-

그룹(5) -/etc/group파일 문서의 도움말 페이지는 이 파일을 사용하여 시스템 그룹을 정의하는 방법을 설명합니다. -

passwd(5) - 이 파일을 사용하여 사용자 정보를 정의하는 방법을/etc/passwd파일의 도움말 페이지. -

shadow(5) - 이 파일을 사용하여 시스템에 대한 암호 및 계정 만료 정보를 설정하는 방법을 설명합니다.

온라인 문서

- Red Hat Enterprise Linux 7 보안 가이드 - Red Hat Enterprise Linux 7의 보안 가이드에서 는 암호 사용 기간 및 사용자 계정 잠금을 활성화하여 암호 보안과 워크스테이션을 보호하는 방법에 대한 추가 정보를 제공합니다.

예를 들면 다음과 같습니다.

-

6장. 권한 확보

su및sudo명령을 사용하여 관리 권한을 얻는 방법에 대해 설명합니다.

5장. 액세스 제어 목록

파일 및 디렉터리에는 파일 소유자, 파일과 연결된 그룹, 시스템의 기타 모든 사용자에 대한 권한 세트가 있습니다. 그러나 이러한 권한 세트에는 제한 사항이 있습니다. 예를 들어 다른 사용자에 대해 다른 권한을 구성할 수 없습니다. 따라서 ACL( 액세스 제어 목록 )이 구현되었습니다.

Red Hat Enterprise Linux 커널은 ext3 파일 시스템과 NFS 내보내기 파일 시스템에 대한 ACL 지원을 제공합니다. ACL은 Samba를 통해 액세스하는 ext3 파일 시스템에서도 인식됩니다.

커널의 지원과 함께 ACL을 구현하려면 acl 패키지가 필요합니다. 여기에는 ACL 정보를 추가, 수정, 제거 및 검색하는 데 사용되는 유틸리티가 포함되어 있습니다.

cp 및 mv 명령은 파일 및 디렉터리와 관련된 모든 ACL을 복사하거나 이동합니다.

5.1. 파일 시스템 마운트

파일 또는 디렉토리에 ACL을 사용하기 전에 파일 또는 디렉터리의 파티션을 ACL 지원으로 마운트해야 합니다. 로컬 ext3 파일 시스템인 경우 다음 명령을 사용하여 마운트할 수 있습니다.

mount -t ext3 -o acl device-name 파티션

예를 들면 다음과 같습니다.

mount -t ext3 -o acl /dev/VolGroup00/LogVol02 /work

또는 /etc/fstab 파일에 파티션이 나열된 경우 파티션에 대한 항목에 acl 옵션이 포함될 수 있습니다.

LABEL=/work /work ext3 acl 1 2

LABEL=/work /work ext3 acl 1 2

Samba를 통해 ext3 파일 시스템에 액세스하고 ACL이 활성화되어 있는 경우 Samba가 --with-acl-support 옵션으로 컴파일되었기 때문에 ACL이 인식됩니다. Samba 공유에 액세스하거나 마운트할 때는 특별한 플래그가 필요하지 않습니다.

5.1.1. NFS

기본적으로 NFS 서버에서 내보내는 파일 시스템이 ACL을 지원하고 NFS 클라이언트가 ACL을 읽을 수 있는 경우 클라이언트 시스템에서 ACL을 사용합니다.

서버를 구성할 때 NFS 공유에서 ACL을 비활성화하려면 /etc/exports 파일에 no_acl 옵션을 포함합니다. 클라이언트에 마운트할 때 NFS 공유에서 ACL을 비활성화하려면 명령줄 또는 /etc/fstab 파일을 통해 no_acl 옵션으로 마운트합니다.

5.2. 액세스 ACL 설정

ACL에는 액세스 ACL과 기본 ACL 의 두 가지 유형이 있습니다. 액세스 ACL은 특정 파일 또는 디렉터리의 액세스 제어 목록입니다. 기본 ACL은 디렉터리와만 연결할 수 있습니다. 디렉터리 내의 파일에 액세스 ACL이 없는 경우 디렉터리에 대한 기본 ACL의 규칙을 사용합니다. 기본 ACL은 선택 사항입니다.

ACL을 구성할 수 있습니다.

- 사용자당

- 그룹당

- 효과적인 권한 마스크를 통해

- 파일의 사용자 그룹에 없는 사용자의 경우

setfacl 유틸리티는 파일 및 디렉터리에 대한 ACL을 설정합니다. m 옵션을 사용하여 파일 또는 디렉터리의 ACL을 추가하거나 수정합니다.

setfacl -m rules files

# setfacl -m rules files규칙(규칙)은 다음 형식으로 지정해야 합니다. 동일한 명령에서 쉼표로 구분된 경우 여러 규칙을 지정할 수 있습니다.

u:uid:perms- 사용자의 액세스 ACL을 설정합니다. 사용자 이름 또는 UID를 지정할 수 있습니다. 사용자는 시스템에서 유효한 사용자일 수 있습니다.

g:gid:perms- 그룹에 대한 액세스 ACL을 설정합니다. 그룹 이름 또는 GID를 지정할 수 있습니다. 그룹은 시스템에서 유효한 그룹일 수 있습니다.

m:perms- 효과적인 권한 마스크를 설정합니다. 마스크는 소유 그룹의 모든 권한과 모든 사용자 및 그룹 항목을 통합합니다.

o:perms- 파일에 대해 그룹에 있는 그룹 이외의 사용자에 대해 액세스 ACL을 설정합니다.

권한(ms)은 읽기, 쓰기, 실행의 경우 r,w, x 의 조합이어야 합니다.

파일 또는 디렉터리에 이미 ACL이 있고 setfacl 명령이 사용되는 경우 기존 ACL에 추가 규칙이 추가되거나 기존 규칙이 수정됩니다.

예 5.1. 읽기 및 쓰기 권한 제공

예를 들어 사용자 및rius에 읽기 및 쓰기 권한을 제공하려면 다음을 수행합니다.

setfacl -m u:andrius:rw /project/somefile

# setfacl -m u:andrius:rw /project/somefile

사용자, 그룹 또는 기타 기타에 대한 모든 권한을 제거하려면 -x 옵션을 사용하고 권한을 지정하지 마십시오.

setfacl -x rules files

# setfacl -x rules files예 5.2. 모든 권한 제거

예를 들어 UID가 500인 사용자의 모든 권한을 제거하려면 다음을 실행합니다.

setfacl -x u:500 /project/somefile

# setfacl -x u:500 /project/somefile5.3. 기본 ACL 설정

기본 ACL을 설정하려면 규칙 앞에 d: 를 추가하고 파일 이름 대신 디렉터리를 지정합니다.

예 5.3. 기본 ACL 설정

예를 들어 /share/ 디렉터리의 기본 ACL을 사용자 그룹이 아닌 사용자에 대해 읽고 실행되도록 설정하려면 개별 파일의 액세스 ACL은 재정의할 수 있습니다.

setfacl -m d:o:rx /share

# setfacl -m d:o:rx /share5.4. ACL 검색

파일 또는 디렉토리에 대한 기존 ACL을 확인하려면 getfacl 명령을 사용합니다. 아래 예제에서 getfacl 은 파일의 기존 ACL을 결정하는 데 사용됩니다.

예 5.4. ACL 검색

getfacl home/john/picture.png

# getfacl home/john/picture.png위의 명령은 다음 출력을 반환합니다.

기본 ACL이 있는 디렉터리가 지정된 경우 다음과 같이 기본 ACL도 표시됩니다. 예를 들어, getfacl home/ sales/ 는 유사한 출력을 표시합니다.

5.5. ACL을 사용하여 파일 시스템 아카이브

기본적으로 dump 명령은 백업 작업 중에 ACL을 보존합니다. tar 로 파일 또는 파일 시스템을 보관하는 경우 --acls 옵션을 사용하여 ACL을 보존합니다. 마찬가지로 cp 를 사용하여 ACL이 포함된 파일을 복사할 때 --preserve=mode 옵션을 포함하여 ACL도 복사됩니다. 또한 cp 의 -a 옵션( -dR --preserve=all)은 타임스탬프, SELinux 컨텍스트 등과 같은 기타 정보와 함께 백업 중에 ACL도 유지합니다. 덤프,tar 또는 cp 에 대한 자세한 내용은 해당 도움말 페이지를 참조하십시오.

star 유틸리티는 파일의 아카이브를 생성하는 데 사용할 수 있다는 점에서 tar 유틸리티와 유사하지만 일부 옵션은 다릅니다. 보다 일반적으로 사용되는 옵션 목록은 표 5.1. “별표를 위한 명령줄 옵션” 을 참조하십시오. 사용 가능한 모든 옵션에 대해서는 man star 를 참조하십시오. 이 유틸리티를 사용하려면 star 패키지가 필요합니다.

| 옵션 | 설명 |

|---|---|

|

| 아카이브 파일을 생성합니다. |

|

|

파일을 추출하지 마십시오. |

|

| 아카이브의 파일을 대체합니다. 파일은 아카이브 파일의 끝에 작성되어 모든 파일을 동일한 경로와 파일 이름으로 바꿉니다. |

|

| 아카이브 파일의 내용을 표시합니다. |

|

| 아카이브 파일을 업데이트합니다. 아카이브가 없는 경우 또는 파일이 아카이브에서 동일한 이름의 파일보다 최신인 경우 아카이브의 끝에 파일이 작성됩니다. 이 옵션은 아카이브가 파일이거나 백페이스일 수 있는 차단되지 않은 테이프인 경우에만 작동합니다. |

|

|

아카이브에서 파일을 추출합니다. 아카이브의 |

|

| 가장 중요한 옵션을 표시합니다. |

|

| 가장 중요한 옵션을 표시합니다. |

|

| 아카이브에서 파일을 추출할 때 파일 이름에서 슬래시를 스트라이핑하지 마십시오. 기본적으로 파일을 추출할 때 제거됩니다. |

|

| 생성 또는 추출 시 파일 및 디렉터리와 관련된 모든 ACL을 아카이브하거나 복원합니다. |

5.6. 이전 시스템과의 호환성

지정된 파일 시스템의 모든 파일에 ACL이 설정된 경우 해당 파일 시스템에는 ext_attr 속성이 있습니다. 이 속성은 다음 명령을 사용하여 확인할 수 있습니다.

tune2fs -l filesystem-device

# tune2fs -l filesystem-device

ext_attr 특성을 획득한 파일 시스템은 이전 커널과 함께 마운트할 수 있지만, 이러한 커널은 설정된 ACL을 적용하지 않습니다.

e2fsck 유틸리티 버전 1.22 이상 e2fsprogs 패키지 (Red Hat Enterprise Linux 2.1 및 4의 버전 포함)는 ext_attr 특성을 사용하여 파일 시스템을 확인할 수 있습니다. 이전 버전은 확인을 거부합니다.

5.7. ACL 참조

자세한 내용은 다음 도움말 페이지를 참조하십시오.

-

man acl- ACL에 대한 설명 -

man getfacl- 파일 액세스 제어 목록을 얻는 방법에 대해 설명합니다. -

man setfacl- 파일 액세스 제어 목록을 설정하는 방법 설명 -

man star-star유틸리티 및 해당 많은 옵션에 대해 더 알아보기

6장. 권한 확보

시스템 관리자 및 경우에 따라 관리 권한으로 특정 작업을 수행해야 합니다. root 사용자로 시스템에 액세스하는 것은 잠재적으로 위험하며 시스템과 데이터를 광범위하게 손상시킬 수 있습니다. 이 장에서는 su 및 sudo 와 같은 setuid 프로그램을 사용하여 관리 권한을 얻는 방법에 대해 설명합니다. 이러한 프로그램을 통해 특정 사용자는 높은 수준의 제어 및 시스템 보안을 유지하면서 일반적으로 root 사용자만 사용할 수 있는 작업을 수행할 수 있습니다.

관리 제어, 잠재적인 위험 및 권한있는 액세스의 부적절한 사용으로 인한 데이터 손실을 방지하는 방법에 대한 자세한 내용은 Red Hat Enterprise Linux 7 보안 가이드 를 참조하십시오.

6.1. su utility를 사용하여 관리 액세스 구성

사용자가 su 명령을 실행하면 루트 암호를 입력하라는 메시지가 표시되고 인증 후에 루트 쉘 프롬프트가 표시됩니다.

su 명령을 사용하여 로그인하면 사용자는 root 사용자 이며 시스템에 대한 절대 관리 액세스 권한이 있습니다. 이 액세스에는 SELinux가 활성화된 경우 적용되는 제한 사항이 계속 적용됩니다. 또한 사용자가 root 가 되면 su 명령을 사용하여 암호를 입력하라는 메시지가 표시되지 않고 시스템의 다른 사용자로 변경할 수 있습니다.

이 프로그램은 매우 강력하기 때문에 조직 내 관리자는 명령에 대한 액세스 권한이 있는 사람을 제한해야 할 수 있습니다.

이 작업을 수행하는 가장 간단한 방법 중 하나는 wheel 이라는 특수 관리 그룹에 사용자를 추가하는 것입니다. 이렇게 하려면 root 로 다음 명령을 입력합니다.

usermod -a -G wheel username

~]# usermod -a -G wheel username

이전 명령에서 사용자 이름을 wheel 그룹에 추가하려는 사용자 이름으로 교체합니다.

사용자 설정 툴을 사용하여 다음과 같이 그룹 멤버십을 수정할 수도 있습니다. 이 절차를 수행하려면 관리자 권한이 필요합니다.

-

Super 키를 눌러 활동 개요를 입력하고

사용자를입력한 다음 Enter 를 누릅니다. 사용자 설정 도구가 나타납니다. Super 키는 키보드와 기타 하드웨어에 따라 다양한 길잡이에 표시되지만 일반적으로 스페이스바 왼쪽에 있는 Windows 또는 Command 키로 나타납니다. - 변경을 활성화하려면 버튼을 클릭하고 유효한 관리자 암호를 입력합니다.

- 왼쪽 열에서 사용자 아이콘을 클릭하여 오른쪽 창에 사용자의 속성을 표시합니다.

-

계정 유형을

Standard에서Administrator로 변경합니다. 이렇게 하면 사용자를wheel그룹에 추가합니다.

사용자 도구에 대한 자세한 내용은 4.2절. “그래픽 환경에서 사용자 관리” 을 참조하십시오.

원하는 사용자를 wheel 그룹에 추가한 후 이러한 특정 사용자만 su 명령을 사용하도록 허용하는 것이 좋습니다. 이렇게 하려면 su,/etc/pam.d/su 에 대한 Pluggable Authentication Module (PAM) 구성 파일을 편집합니다. 텍스트 편집기에서 이 파일을 열고 # 문자를 제거하여 다음 행의 주석을 제거합니다.

#auth required pam_wheel.so use_uid

#auth required pam_wheel.so use_uid

이 변경으로 인해 관리 그룹 where의 멤버만 su 명령을 사용하여 다른 사용자로 전환할 수 있습니다.

6.2. sudo utility를 사용하여 관리 액세스 구성

sudo 명령은 사용자에게 관리 액세스 권한을 부여하는 다른 방법을 제공합니다. 신뢰할 수 있는 사용자가 관리자 명령 앞에 sudo 를 입력하면 자신의 암호를 입력하라는 메시지가 표시됩니다. 그런 다음 인증되고 명령이 허용된다고 가정하면 root 사용자인 것처럼 관리 명령이 실행됩니다.

sudo 명령의 기본 형식은 다음과 같습니다.

sudo command

sudo command

위의 예에서 명령은 일반적으로 root 사용자(예: mount )에 예약된 명령으로 교체됩니다.

sudo 명령을 사용하면 높은 수준의 유연성을 제공합니다. 예를 들어 /etc/sudoers 구성 파일에 나열된 사용자만 sudo 명령을 사용할 수 있으며 루트 쉘이 아닌 사용자 쉘에서 명령이 실행됩니다. 즉, Red Hat Enterprise Linux 7 보안 가이드에 표시된 대로 루트 쉘을 완전히 비활성화할 수 있습니다.

sudo 명령을 사용하여 인증에 성공하면 /var/log/ message 파일에 기록되고 발행자의 사용자 이름과 함께 실행된 명령은 /var/log/secure 파일에 기록됩니다. 추가 로깅이 필요한 경우, /etc/pam.d/system-auth 파일에 다음 행을 추가하여 지정된 사용자에 대해 TTY 감사를 활성화하려면 pam_tty_audit 모듈을 사용합니다.

session required pam_tty_audit.so disable=pattern enable=pattern

session required pam_tty_audit.so disable=pattern enable=pattern

여기서 패턴은 glob를 선택적 용도로 사용하는 사용자의 쉼표로 구분된 목록을 나타냅니다. 예를 들어 다음 구성은 root 사용자에 대해 TTY 감사를 활성화하고 다른 모든 사용자에 대해 비활성화합니다.

session required pam_tty_audit.so disable=* enable=root

session required pam_tty_audit.so disable=* enable=root

TTY 감사 레코드에 대한 pam_tty_audit PAM 모듈을 TTY 입력만 구성합니다. 즉, 감사된 사용자가 로그인할 때 interval _tty_audit 는 사용자가 /var/log/audit/audit.log 파일에 만드는 정확한 키 입력을 기록합니다. 자세한 내용은 pam_tty_audit(8) 매뉴얼 페이지를 참조하십시오.

sudo 명령의 또 다른 장점은 관리자가 필요에 따라 특정 명령에 다른 사용자가 액세스할 수 있다는 점입니다.

sudo 구성 파일 /etc/sudoers 를 편집하려는 관리자는 visudo 명령을 사용해야 합니다.

사용자에게 전체 관리 권한을 제공하려면 visudo 를 입력하고 사용자 권한 사양 섹션에서 다음과 유사한 행을 추가합니다.

juan ALL=(ALL) ALL

juan ALL=(ALL) ALL

이 예에서는 사용자(Subjan ) 가 모든 호스트에서 sudo 를 사용하고 모든 명령을 실행할 수 있다고 명시되어 있습니다.

아래 예제에서는 sudo 를 설정할 때 가능한 세분성을 보여줍니다.

%users localhost=/usr/sbin/shutdown -h now

%users localhost=/usr/sbin/shutdown -h now

이 예에서는 사용자 시스템 그룹의 모든 멤버가 콘솔에서 발행되는 한 이제 /sbin/shutdown -h 명령을 실행할 수 있다고 명시되어 있습니다.

sudoers 의 man 페이지에는 이 파일에 대한 자세한 옵션 목록이 있습니다.

/etc/sudoers 파일에서 NO tekton 옵션을 사용하여 암호를 제공하지 않아도 되는 sudo 사용자를 구성할 수도 있습니다.

user_name ALL=(ALL) NOPASSWD: ALL

user_name ALL=(ALL) NOPASSWD: ALL

그러나 이러한 사용자에게도 sudo 는 PAM 모듈에 의해 설정된 제한을 인증 단계 외부에서 확인할 수 있는PAM(Plugable Authentication Module) 계정 관리 모듈을 실행합니다. 이렇게 하면 PAM 모듈이 올바르게 작동합니다. 예를 들어, pam_time 모듈의 경우 시간 기반 계정 제한이 실패하지 않습니다.

항상 모든 PAM 기반 액세스 제어 규칙의 허용된 서비스 목록에 sudo 를 포함합니다. 그렇지 않으면 sudo 에 액세스하려고 할 때 "permission denied" 오류 메시지가 표시되지만 현재 액세스 제어 규칙에 따라 액세스가 금지됩니다.

자세한 내용은 Red Hat Knowledgebase 문서 Red Hat Enterprise Linux 7.6에 패치된 후 sudo에서 권한 거부 오류를 제공합니다.

sudo 명령을 사용할 때 고려해야 할 몇 가지 위험이 있습니다. 위에서 설명한 대로 visudo 를 사용하여 /etc/sudoers 구성 파일을 편집하여 방지할 수 있습니다. /etc/sudoers 파일을 기본 상태로 유지하면 wheel 그룹의 모든 사용자에게 무제한 루트 액세스 권한이 부여됩니다.

기본적으로

sudo는 5분 제한 기간 동안 암호를 저장합니다. 이 기간 동안 명령을 나중에 사용하면 사용자에게 암호를 입력하라는 메시지가 표시되지 않습니다. 이 취약점은 사용자가 워크스테이션이 아직 로그인되어 있는 동안 워크스테이션을 자동으로 잠금 해제하고 잠금 해제하는 경우 공격자가 악용될 수 있습니다. 이 동작은/etc/sudoers파일에 다음 행을 추가하여 변경할 수 있습니다.Defaults timestamp_timeout=value

Defaults timestamp_timeout=valueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 여기서 value 는 원하는 시간 제한 길이(분)입니다. 값을 0으로 설정하면

sudo에서 암호를 매번 필요로 합니다.계정이 손상된 경우 공격자는

sudo를 사용하여 관리자 권한으로 새 쉘을 열 수 있습니다.sudo /bin/bash

sudo /bin/bashCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 또는 유사한 방식으로

root로 새 쉘을 열면 공격자가 이론적으로 무제한으로 제한된 시간 동안 관리 액세스 권한을 부여하고/etc/sudoers파일에 지정된 제한 시간을 무시하고 공격자가 새로 열린 세션이 종료될 때까지sudo에 대한 암호를 다시 입력하지 않아도 됩니다.

6.3. 추가 리소스

사용자가 관리 권한을 얻을 수 있는 프로그램은 잠재적인 보안 위험이지만 보안 자체는 이 특정 책의 범위를 벗어납니다. 따라서 보안 및 권한 있는 액세스에 대한 자세한 내용은 아래 나열된 리소스를 참조해야 합니다.

설치된 문서

-

Su (1) -

su의 도움말 페이지는 이 명령으로 사용 가능한 옵션에 대한 정보를 제공합니다. -

sudo(8) -sudo의 도움말 페이지에는 이 명령에 대한 자세한 설명과 해당 동작을 사용자 정의할 수 있는 옵션이 나열됩니다. -

PAM(8) - Linux용 Pluggable Authentication Modules (PAM) 사용을 설명하는 수동 페이지.

온라인 문서

-

Red Hat Enterprise Linux 7 보안 가이드 - Red Hat Enterprise Linux 7의 보안 가이드에서는

setuid프로그램과 관련된 잠재적인 보안 문제와 이러한 위험을 완화하는 데 사용되는 기술을 자세히 설명합니다.

예를 들면 다음과 같습니다.

- 4장. 사용자 및 그룹 관리 그래픽 사용자 인터페이스 및 명령줄에서 시스템 사용자 및 그룹을 관리하는 방법을 설명합니다.

II 부. 서브스크립션 및 지원

Red Hat Enterprise Linux 시스템에서 소프트웨어 업데이트를 받으려면 Red HatCDN( Content Delivery Network ) 및 적절한 리포지토리를 활성화해야 합니다. 이 부분에서는 시스템을 Red Hat Content Delivery Network에 등록하는 방법을 설명합니다.

Red Hat은 고객 포털 을 통해 지원을 제공하며 Red Hat 지원 도구를 사용하여 명령줄에서 직접 이 지원에 액세스할 수 있습니다. 이 부분에서는 이 명령줄 툴의 사용에 대해 설명합니다.

7장. 시스템 등록 및 서브스크립션 관리

서브스크립션 서비스는 Red Hat 소프트웨어 인벤토리를 처리하는 메커니즘을 제공하며 yum 패키지 관리자를 사용하여 이미 설치된 프로그램을 최신 버전에 추가로 설치할 수 있습니다. Red Hat Enterprise Linux 7에서 시스템을 등록하고 서브스크립션을 첨부하는 것이 Red Hat 서브스크립션 관리를 사용하는 것이 좋습니다.

7.1. 시스템 및 연결 서브스크립션 등록

시스템을 등록하고 Red Hat 서브스크립션 관리를 사용하여 서브스크립션을 하나 이상 연결하려면 다음 단계를 완료합니다. 모든 subscription-manager 명령은 root 로 실행되어야 합니다.

다음 명령을 실행하여 시스템을 등록합니다. 사용자 이름과 암호를 입력하라는 메시지가 표시됩니다. 사용자 이름과 암호는 Red Hat Customer Portal의 로그인 자격 증명과 동일합니다.

subscription-manager register

subscription-manager registerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 필요한 서브스크립션의 풀 ID를 확인합니다. 이렇게 하려면 쉘 프롬프트에서 다음을 입력하여 시스템에 사용 가능한 모든 서브스크립션 목록을 표시합니다.

subscription-manager list --available

subscription-manager list --availableCopy to Clipboard Copied! Toggle word wrap Toggle overflow 사용 가능한 서브스크립션마다 이 명령은 서브스크립션과 관련된 이름, 고유 식별자, 만료일 및 기타 세부 정보를 표시합니다. 모든 아키텍처의 서브스크립션을 나열하려면

--all옵션을 추가합니다. 풀 ID는풀 ID로 시작하는 줄에 나열됩니다.다음과 같이 명령을 입력하여 시스템에 적절한 서브스크립션을 연결합니다.

subscription-manager attach --pool=pool_id

subscription-manager attach --pool=pool_idCopy to Clipboard Copied! Toggle word wrap Toggle overflow pool_id 를 이전 단계에서 결정한 풀 ID로 교체합니다.

언제든지 시스템이 현재 연결된 서브스크립션 목록을 확인하려면 다음을 실행합니다.

subscription-manager list --consumed

subscription-manager list --consumedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Red Hat Subscription Management를 사용하여 시스템을 등록하고 서브스크립션과 연결하는 방법에 대한 자세한 내용은 지정된 솔루션 문서를 참조하십시오. 서브스크립션에 대한 자세한 내용은 Red Hat Subscription Management 가이드 컬렉션을 참조하십시오.

7.2. 소프트웨어 리포지토리 관리

Red Hat Content Delivery Network를 시스템이 서브스크립션하면 /etc/yum.repos.d/ 디렉토리에 리포지토리 파일이 생성됩니다. 이를 확인하려면 yum 을 사용하여 활성화된 모든 리포지토리를 나열합니다.

yum repolist

yum repolistRed Hat 서브스크립션 관리를 사용하면 Red Hat에서 제공하는 소프트웨어 리포지토리를 수동으로 활성화 또는 비활성화할 수 있습니다. 사용 가능한 리포지토리를 모두 나열하려면 다음 명령을 사용하십시오.

subscription-manager repos --list

subscription-manager repos --list리포지토리 이름은 사용 중인 특정 Red Hat Enterprise Linux 버전에 따라 다르며 형식은 다음과 같습니다.

rhel-version-variant-rpms rhel-version-variant-debug-rpms rhel-version-variant-source-rpms

rhel-version-variant-rpms

rhel-version-variant-debug-rpms

rhel-version-variant-source-rpms

여기서 버전은 Red Hat Enterprise Linux 시스템 버전(6 또는 7)이며, 변형 은 Red Hat Enterprise Linux 시스템 변형(서버 또는 워크스테이션)입니다. 예를 들면 다음과 같습니다.

rhel-7-server-rpms rhel-7-server-debug-rpms rhel-7-server-source-rpms

rhel-7-server-rpms

rhel-7-server-debug-rpms

rhel-7-server-source-rpms리포지토리를 활성화하려면 다음과 같이 명령을 입력합니다.

subscription-manager repos --enable repository

subscription-manager repos --enable repository리포지토리를 활성화할 리포지토리 이름으로 교체합니다.

마찬가지로 리포지토리를 비활성화하려면 다음 명령을 사용합니다.

subscription-manager repos --disable repository

subscription-manager repos --disable repository9.5절. “YUM 및 YUM 리포지토리 구성” yum 을 사용하여 소프트웨어 리포지토리 관리에 대한 자세한 정보를 제공합니다.

리포지토리를 자동으로 업데이트하려면 yum-cron 서비스를 사용할 수 있습니다. 자세한 내용은 9.7절. “YUM-cron을 사용하여 패키지 데이터베이스 자동 새로 고침 및 업데이트 다운로드”의 내용을 참조하십시오.

7.3. 서브스크립션 제거

특정 서브스크립션을 제거하려면 다음 단계를 완료하십시오.

이미 연결된 서브스크립션에 대한 정보를 나열하여 제거할 서브스크립션의 일련 번호를 결정합니다.

subscription-manager list --consumed

subscription-manager list --consumedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 일련 번호는

serial으로 나열된 번호입니다. 예를 들어 아래 예제에서744993814251016831은 다음과 같습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같이 명령을 입력하여 선택한 서브스크립션을 제거합니다.

subscription-manager remove --serial=serial_number

subscription-manager remove --serial=serial_numberCopy to Clipboard Copied! Toggle word wrap Toggle overflow serial_number 를 이전 단계에서 결정한 일련 번호로 바꿉니다.

시스템에 연결된 모든 서브스크립션을 제거하려면 다음 명령을 실행합니다.

subscription-manager remove --all

subscription-manager remove --all7.4. 추가 리소스

Red Hat Subscription Management를 사용하여 시스템을 등록하고 서브스크립션과 연결하는 방법에 대한 자세한 내용은 아래 나열된 리소스를 참조하십시오.

설치된 문서

-

subscription-manager(8) - Red Hat 서브스크립션 관리에 대한 도움말 페이지는 지원되는 옵션 및 명령의 전체 목록을 제공합니다.

관련 도서

- Red Hat Subscription Management 가이드 수집 - 이 안내서에는 Red Hat 서브스크립션 관리 사용 방법에 대한 자세한 정보가 포함되어 있습니다.

- 설치 가이드 - 초기 설정 프로세스 중에 등록하는 방법에 대한 자세한 내용은 초기 설정 장을 참조하십시오.

예를 들면 다음과 같습니다.

8장. Red Hat 지원 도구를 사용하여 지원에 액세스

redhat-support-tool 패키지의 Red Hat 지원 툴 은 대화형 쉘과 단일 실행 프로그램으로 기능할 수 있습니다. SSH 를 통해 실행하거나 모든 터미널에서 실행할 수 있습니다. 예를 들어 명령줄에서 Red Hat 지식 베이스를 검색하고 명령줄에 직접 솔루션을 복사하고, 지원 케이스를 열고 업데이트하고, 분석을 위해 Red Hat으로 파일을 전송할 수 있습니다.

8.1. Red Hat 지원 도구 설치

Red Hat 지원 도구는 기본적으로 Red Hat Enterprise Linux에 설치됩니다. 필요한 경우 root 로 다음 명령을 입력합니다.

yum install redhat-support-tool

~]# yum install redhat-support-tool8.2. 명령줄을 사용하여 Red Hat 지원 도구 등록

명령줄을 사용하여 Red Hat 지원 도구를 고객 포털에 등록하려면 다음 명령을 실행합니다.