논리 볼륨 구성 및 관리

LVM 구성 및 관리

초록

Red Hat 문서에 관한 피드백 제공

문서에 대한 피드백에 감사드립니다. 어떻게 개선할 수 있는지 알려주십시오.

Jira를 통해 피드백 제출 (등록 필요)

- Jira 웹 사이트에 로그인합니다.

- 상단 탐색 모음에서 생성 을 클릭합니다.

- Summary (요약) 필드에 설명 제목을 입력합니다.

- Description (설명) 필드에 개선을 위한 제안을 입력합니다. 문서의 관련 부분에 대한 링크를 포함합니다.

- 대화 상자 하단에서 생성 을 클릭합니다.

1장. 논리 볼륨 관리 개요

LVM(Logical Volume Manager)은 물리 스토리지에 대한 추상화 계층을 생성하므로 논리 스토리지 볼륨을 생성할 수 있습니다. 이를 통해 직접 물리적 스토리지 사용량에 비해 유연성이 향상됩니다.

또한 하드웨어 스토리지 구성이 소프트웨어에 숨겨져 있으므로 애플리케이션을 중지하거나 파일 시스템을 마운트 해제하지 않고도 크기를 조정하고 이동할 수 있습니다. 이는 운영 비용을 절감할 수 있습니다.

1.1. LVM 아키텍처

다음은 LVM의 구성 요소입니다.

- 물리 볼륨

- PV(물리 볼륨)는 LVM 사용을 위해 지정된 파티션 또는 전체 디스크입니다. 자세한 내용은 LVM 물리 볼륨 관리를 참조하십시오.

- 볼륨 그룹

- 볼륨 그룹(VG)은 논리 볼륨을 할당할 수 있는 디스크 공간 풀을 생성하는 PV(물리 볼륨) 컬렉션입니다. 자세한 내용은 LVM 볼륨 그룹 관리를 참조하십시오.

- 논리 볼륨

- 논리 볼륨은 사용 가능한 스토리지 장치를 나타냅니다. 자세한 내용은 기본 논리 볼륨 관리 및 고급 논리 볼륨 관리를 참조하십시오.

다음 다이어그램은 LVM 구성 요소를 보여줍니다.

그림 1.1. LVM 논리 볼륨 구성 요소

1.2. LVM의 장점

논리 볼륨은 물리 스토리지를 직접 사용하는 것보다 다음과 같은 이점을 제공합니다.

- 유연한 용량

- 논리 볼륨을 사용하는 경우 장치 및 파티션을 단일 논리 볼륨에 집계할 수 있습니다. 이 기능을 사용하면 파일 시스템을 단일 대규모 장치처럼 여러 장치에 걸쳐 확장할 수 있습니다.

- 편리한 장치 이름 지정

- 논리 스토리지 볼륨은 사용자 정의 및 사용자 정의 이름으로 관리할 수 있습니다.

- 크기 조정할 수 있는 스토리지 볼륨

- 기본 장치를 다시 포맷하고 다시 분할하지 않고도 간단한 소프트웨어 명령으로 논리 볼륨을 확장하거나 논리 볼륨을 줄일 수 있습니다. 자세한 내용은 논리 볼륨 재조정 을 참조하십시오.

- 온라인 데이터 재배치

최신 스토리지 하위 시스템을 배포하려면

pvmove명령을 사용하여 시스템을 활성화하는 동안 데이터를 이동할 수 있습니다. 디스크를 사용하는 동안 디스크에 데이터를 다시 정렬할 수 있습니다. 예를 들어, 제거하기 전에 핫 스왑 가능 디스크를 비울 수 있습니다.데이터를 마이그레이션하는 방법에 대한 자세한 내용은

pvmove도움말 페이지 및 볼륨 그룹에서 물리 볼륨 제거를 참조하십시오.- 스트라이핑된 볼륨

- 두 개 이상의 장치에서 데이터를 스트라이핑하는 논리 볼륨을 만들 수 있습니다. 이로 인해 처리량이 크게 증가할 수 있습니다. 자세한 내용은 스트라이핑된 논리 볼륨 생성 을 참조하십시오.

- RAID 볼륨

- 논리 볼륨은 편리하게 데이터에 대한 RAID를 구성할 수 있는 방법을 제공합니다. 이로 인해 장치 장애에 대한 보호가 가능하며 성능이 향상됩니다. 자세한 내용은 RAID 논리 볼륨 구성 을 참조하십시오.

- 볼륨 스냅샷

- 일관된 백업을 위해 논리 볼륨의 시점 복사본인 스냅샷을 찍거나 실제 데이터에 영향을 주지 않고 변경의 영향을 테스트할 수 있습니다. 자세한 내용은 논리 볼륨 스냅샷 관리를 참조하십시오.

- 씬 볼륨

- 논리 볼륨은 씬 프로비저닝할 수 있습니다. 이를 통해 사용 가능한 물리 공간보다 큰 논리 볼륨을 만들 수 있습니다. 자세한 내용은 thin 논리 볼륨 생성 을 참조하십시오.

- 캐싱

- 캐싱은 SSD와 같은 빠른 장치를 사용하여 논리 볼륨의 데이터를 캐시하여 성능을 향상시킵니다. 자세한 내용은 논리 볼륨 캐싱 을 참조하십시오.

2장. LVM 물리 볼륨 관리

PV(물리 볼륨)는 LVM에서 사용하는 스토리지 장치의 물리 스토리지 장치 또는 파티션입니다.

초기화 프로세스 중에 LVM 디스크 레이블 및 메타데이터가 장치에 기록되므로 LVM에서 논리 볼륨 관리 스키마의 일부로 이를 추적하고 관리할 수 있습니다.

초기화 후에는 메타데이터 크기를 늘릴 수 없습니다. 더 큰 메타데이터가 필요한 경우 초기화 프로세스 중에 적절한 크기를 설정해야 합니다.

초기화 프로세스가 완료되면 PV를 볼륨 그룹(VG)에 할당할 수 있습니다. 이 VG를 운영 체제와 애플리케이션에 사용할 수 있는 가상 블록 장치인 LV(논리 볼륨)로 나눌 수 있습니다.

최적의 성능을 보장하기 위해 LVM을 사용할 수 있도록 전체 디스크를 단일 PV로 분할합니다.

2.1. LVM 물리 볼륨 생성

pvcreate 명령을 사용하여 물리 볼륨 LVM 사용을 초기화할 수 있습니다.

사전 요구 사항

- 관리 액세스.

-

lvm2패키지가 설치되어 있습니다.

절차

물리 볼륨으로 사용할 스토리지 장치를 식별합니다. 사용 가능한 모든 스토리지 장치를 나열하려면 다음을 사용합니다.

lsblk

$ lsblkCopy to Clipboard Copied! Toggle word wrap Toggle overflow LVM 물리 볼륨을 생성합니다.

pvcreate /dev/sdb

# pvcreate /dev/sdbCopy to Clipboard Copied! Toggle word wrap Toggle overflow /dev/sdb 를 물리 볼륨으로 초기화하려는 장치 이름으로 바꿉니다.

검증 단계

생성된 물리 볼륨을 표시합니다.

pvs PV VG Fmt Attr PSize PFree /dev/sdb lvm2 a-- 28.87g 13.87g

# pvs PV VG Fmt Attr PSize PFree /dev/sdb lvm2 a-- 28.87g 13.87gCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2. 스토리지 RHEL 시스템 역할을 사용하여 물리 볼륨 크기 조정

스토리지 시스템 역할을 사용하면 호스트 외부에서 기본 스토리지 또는 디스크의 크기를 조정한 후 LVM 물리 볼륨의 크기를 조정할 수 있습니다. 예를 들어 가상 디스크의 크기가 증가하여 기존 LVM에서 추가 공간을 사용하려고 합니다.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다. - 기본 블록 스토리지의 크기가 변경되었습니다.

절차

다음 콘텐츠를 사용하여 플레이북 파일(예:

~/playbook.yml)을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 플레이북에 사용되는 모든 변수에 대한 자세한 내용은 제어 노드의

/usr/share/ansible/roles/rhel-system-roles.storage/README.md파일을 참조하십시오.플레이북 구문을 확인합니다.

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

새 물리 볼륨 크기를 표시합니다.

ansible managed-node-01.example.com -m command -a 'pvs' PV VG Fmt Attr PSize PFree /dev/sdf1 myvg lvm2 a-- 1,99g 1,99g

$ ansible managed-node-01.example.com -m command -a 'pvs' PV VG Fmt Attr PSize PFree /dev/sdf1 myvg lvm2 a-- 1,99g 1,99gCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. LVM 물리 볼륨 제거

pvremove 명령을 사용하여 LVM 사용의 물리 볼륨을 제거할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

물리 볼륨을 나열하여 제거할 장치를 식별합니다.

pvs PV VG Fmt Attr PSize PFree /dev/sdb1 lvm2 --- 28.87g 28.87g

# pvs PV VG Fmt Attr PSize PFree /dev/sdb1 lvm2 --- 28.87g 28.87gCopy to Clipboard Copied! Toggle word wrap Toggle overflow 물리 볼륨 제거:

pvremove /dev/sdb1

# pvremove /dev/sdb1Copy to Clipboard Copied! Toggle word wrap Toggle overflow /dev/sdb1 을 물리 볼륨과 연결된 장치의 이름으로 바꿉니다.

물리 볼륨이 볼륨 그룹의 일부인 경우 먼저 볼륨 그룹에서 제거해야 합니다.

볼륨 그룹에 하나 이상의 물리 볼륨이 포함된 경우 Cryostatreduce

명령을사용합니다.vgreduce VolumeGroupName /dev/sdb1

# vgreduce VolumeGroupName /dev/sdb1Copy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. /dev/sdb1 을 장치 이름으로 바꿉니다.

볼륨 그룹에 하나의 물리 볼륨이 포함된 경우 Cryostat

remove명령을 사용합니다.vgremove VolumeGroupName

# vgremove VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다.

검증

물리 볼륨이 제거되었는지 확인합니다.

pvs

# pvsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

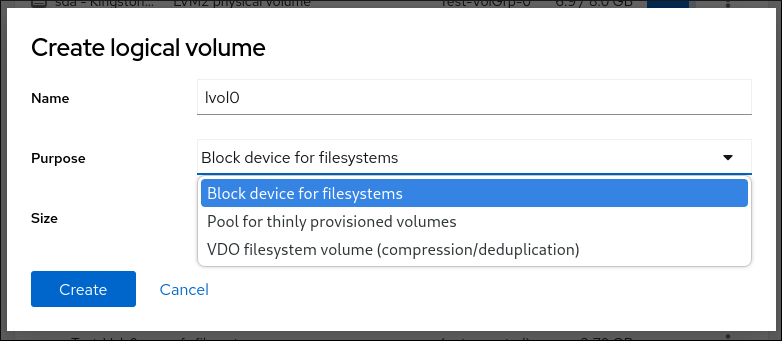

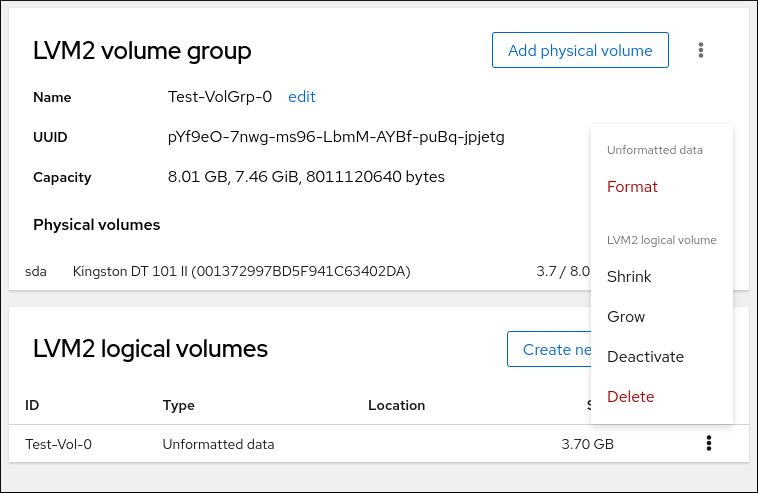

2.4. 웹 콘솔에서 논리 볼륨 생성

논리 볼륨은 물리 드라이브 역할을 합니다. RHEL 9 웹 콘솔을 사용하여 볼륨 그룹에 LVM 논리 볼륨을 생성할 수 있습니다.

사전 요구 사항

- RHEL 9 웹 콘솔을 설치했습니다.

- cockpit 서비스를 활성화했습니다.

사용자 계정이 웹 콘솔에 로그인할 수 있습니다.

자세한 내용은 웹 콘솔 설치 및 활성화를 참조하십시오.

-

cockpit-storaged패키지가 시스템에 설치됩니다. - 볼륨 그룹이 생성됩니다.

절차

RHEL 9 웹 콘솔에 로그인합니다.

자세한 내용은 웹 콘솔에 로그인 을 참조하십시오.

- 스토리지를 클릭합니다.

- 스토리지 테이블에서 논리 볼륨을 생성할 볼륨 그룹을 클릭합니다.

- 논리 볼륨 그룹 페이지에서 LVM2 논리 볼륨 섹션으로 스크롤하고 만들기 를 클릭합니다.

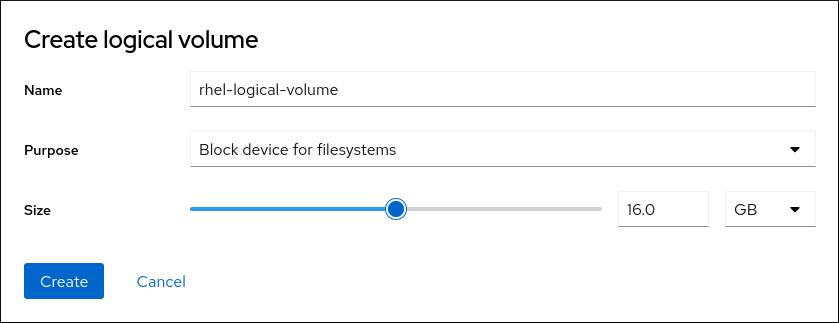

- 이름 필드에 새 논리 볼륨의 이름을 입력합니다. 이름에 공백을 포함하지 마십시오.

(용도) 드롭다운 메뉴에서 파일 시스템에 대한 블록 장치를 선택합니다.

이 구성을 사용하면 볼륨 그룹에 포함된 모든 드라이브의 용량 합계와 동일한 최대 볼륨 크기를 사용하여 논리 볼륨을 생성할 수 있습니다.

논리 볼륨의 크기를 정의합니다. 다음을 고려하십시오.

- 이 논리 볼륨을 사용하는 시스템에 얼마나 많은 공간이 필요합니까.

- 생성할 논리 볼륨 수입니다.

전체 공간을 사용할 필요는 없습니다. 필요한 경우 나중에 논리 볼륨을 확장할 수 있습니다.

을 클릭합니다.

논리 볼륨이 생성됩니다. 논리 볼륨을 사용하려면 볼륨을 포맷하고 마운트해야 합니다.

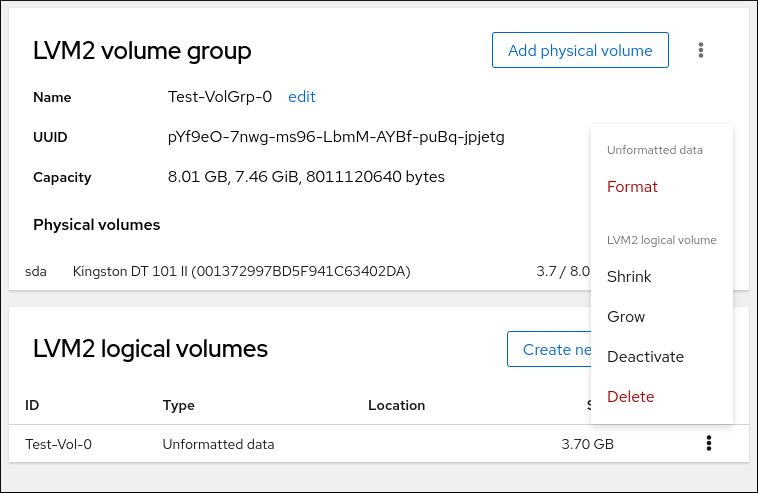

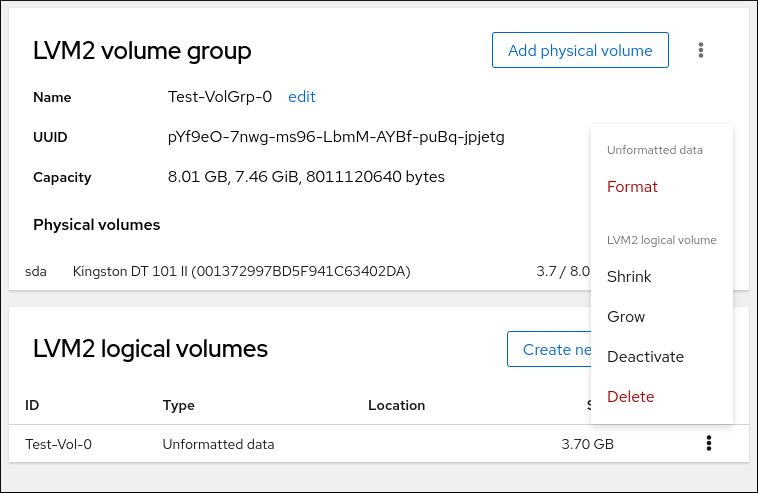

검증

논리 볼륨 페이지에서 LVM2 논리 볼륨 섹션으로 스크롤하고 새 논리 볼륨이 나열되는지 확인합니다.

2.5. 웹 콘솔에서 논리 볼륨 포맷

논리 볼륨은 물리 드라이브 역할을 합니다. 이를 사용하려면 파일 시스템으로 포맷해야 합니다.

논리 볼륨을 포맷하면 볼륨의 모든 데이터가 지워집니다.

선택한 파일 시스템에 논리 볼륨에 사용할 수 있는 구성 매개변수가 결정됩니다. 예를 들어 XFS 파일 시스템은 볼륨 축소를 지원하지 않습니다.

사전 요구 사항

- RHEL 9 웹 콘솔을 설치했습니다.

- cockpit 서비스를 활성화했습니다.

사용자 계정이 웹 콘솔에 로그인할 수 있습니다.

자세한 내용은 웹 콘솔 설치 및 활성화를 참조하십시오.

-

cockpit-storaged패키지가 시스템에 설치됩니다. - 생성된 논리 볼륨입니다.

- 시스템에 대한 root 액세스 권한이 있습니다.

절차

RHEL 9 웹 콘솔에 로그인합니다.

자세한 내용은 웹 콘솔에 로그인 을 참조하십시오.

- 스토리지를 .

- 스토리지 표에서 논리 볼륨의 볼륨 그룹이 생성됩니다.

- 논리 볼륨 그룹 페이지에서 LVM2 논리 볼륨 섹션으로 스크롤합니다.

- 포맷할 볼륨 그룹 옆에 있는 메뉴 버튼 Cryostat를 클릭합니다.

드롭다운 메뉴에서 선택합니다.

- 이름 필드에 파일 시스템의 이름을 입력합니다.

마운트 지점 필드에서 마운트 경로를 추가합니다.

드롭다운 메뉴에서 파일 시스템을 선택합니다.

XFS 파일 시스템은 대규모 논리 볼륨을 지원하며 중단 없이 물리적 드라이브를 온라인 상태로 전환하며 기존 파일 시스템을 확장합니다. 다른 강력한 기본 설정이 없는 경우 이 파일 시스템을 선택한 상태로 두십시오.

XFS는 XFS 파일 시스템으로 포맷된 볼륨의 크기 감소를 지원하지 않습니다.

ext4 파일 시스템은 다음을 지원합니다.

- 논리 볼륨

- 중단 없이 온라인으로 물리적 드라이브 전환

- 파일 시스템 확장

- 파일 시스템 축소

RHEL 웹 콘솔에서 0으로 전체 디스크를 다시 작성하려면 0이 포함된 기존 데이터 덮어쓰기 확인란을 선택합니다. 이 옵션은 프로그램이 전체 디스크를 통과해야 하지만 더 안전합니다. 디스크에 데이터가 포함되어 있고 덮어써야 하는 경우 이 옵션을 사용합니다.

제로가 0인 기존 데이터를 덮어쓰 지 않은 경우 RHEL 웹 콘솔은 디스크 헤더만 다시 작성합니다. 이렇게 하면 포맷 속도가 증가합니다.

드롭다운 메뉴에서 논리 볼륨에서 암호화 유형을 활성화하려면 선택합니다.

LUKS1(Linux Unified Key Setup) 또는 LUKS2 암호화가 있는 버전을 선택하여 암호를 사용하여 볼륨을 암호화할 수 있습니다.

- 드롭다운 메뉴에서 시스템이 부팅된 후 논리 볼륨을 마운트할 시기를 선택합니다.

- 필요한 마운트 옵션을 선택합니다.

논리 볼륨을 포맷합니다.

- 볼륨을 포맷하고 즉시 마운트하려면 합니다.

마운트하지 않고 볼륨을 포맷하려면 클릭합니다.

볼륨 크기 및 선택한 포맷 옵션에 따라 포맷 지정에 몇 분이 걸릴 수 있습니다.

검증

논리 볼륨 그룹 페이지에서 LVM2 논리 볼륨 섹션으로 스크롤하고 논리 볼륨을 클릭하여 세부 정보 및 추가 옵션을 확인합니다.

- 옵션을 선택한 경우 논리 볼륨 행 끝에 있는 메뉴 버튼을 클릭하고 를 선택하여 논리 볼륨을 사용합니다.

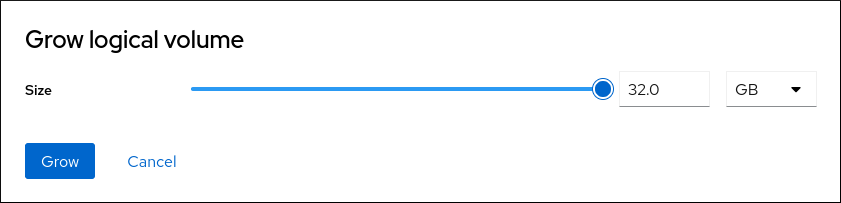

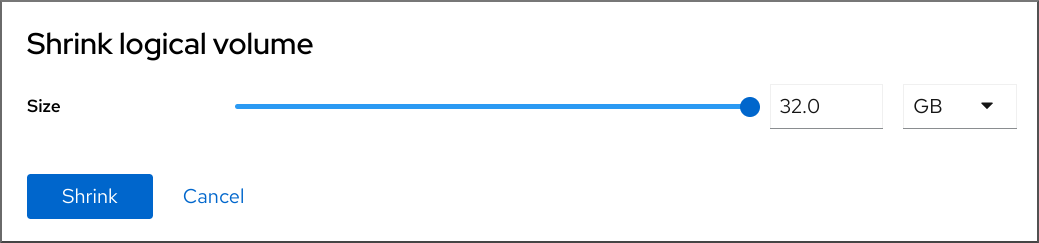

2.6. 웹 콘솔에서 논리 볼륨 크기 조정

RHEL 9 웹 콘솔에서 논리 볼륨을 확장하거나 줄일 수 있습니다. 예제 절차에서는 볼륨을 오프라인 상태로 전환하지 않고 논리 볼륨의 크기를 늘리고 줄이는 방법을 보여줍니다.

polkit2 또는 XFS 파일 시스템이 포함된 볼륨을 줄일 수 없습니다.

사전 요구 사항

- RHEL 9 웹 콘솔을 설치했습니다.

- cockpit 서비스를 활성화했습니다.

사용자 계정이 웹 콘솔에 로그인할 수 있습니다.

자세한 내용은 웹 콘솔 설치 및 활성화를 참조하십시오.

-

cockpit-storaged패키지가 시스템에 설치됩니다. - 논리 볼륨 크기 조정을 지원하는 파일 시스템이 포함된 기존 논리 볼륨.

절차

- RHEL 웹 콘솔에 로그인합니다.

- 스토리지를 .

- 스토리지 표에서 논리 볼륨의 볼륨 그룹이 생성됩니다.

논리 볼륨 그룹 페이지에서 LVM2 논리 볼륨 섹션으로 스크롤하고 크기를 조정할 볼륨 그룹 옆에 있는 Cryostat 메뉴 버튼을 클릭합니다.

메뉴에서 Grow 또는 Shrink 를 선택하여 볼륨의 크기를 조정합니다.

볼륨 확장:

- 를 선택하여 볼륨의 크기를 늘립니다.

Grow 논리 볼륨 대화 상자에서 논리 볼륨의 크기를 조정합니다.

확장 을 .

LVM은 시스템을 중단하지 않고 논리 볼륨을 늘립니다.

볼륨 축소:

- 를 선택하여 볼륨의 크기를 줄입니다.

Shrink 논리 볼륨 대화 상자에서 논리 볼륨의 크기를 조정합니다.

를 클릭합니다.

LVM은 시스템을 중단하지 않고 논리 볼륨을 축소합니다.

3장. LVM 볼륨 그룹 관리

볼륨 그룹(VG)을 생성하고 사용하여 단일 스토리지 엔티티로 결합된 여러 PV(물리 볼륨)를 관리하고 크기를 조정할 수 있습니다.

Extent는 LVM에서 할당할 수 있는 가장 작은 공간 단위입니다. 물리 확장 영역(PE) 및 논리 확장 영역(LE)의 기본 크기는 구성할 수 있는 4MiB입니다. 모든 Extent의 크기가 동일합니다.

VG 내에 논리 볼륨(LV)을 생성하면 LVM에서 PV에 물리 확장 영역을 할당합니다. LV 내의 논리 확장 영역은 VG의 물리 확장 영역과 함께 1대1에 해당합니다. LV를 만들기 위해 PE를 지정할 필요가 없습니다. LVM은 사용 가능한 PE를 찾아서 함께 구성하여 요청된 크기의 LV를 만듭니다.

VG 내에서 각각 기존 파티션처럼 작동하지만 물리 볼륨에 걸쳐 확장되고 동적으로 크기를 조정할 수 있는 LV를 여러 개 만들 수 있습니다. VG는 디스크 공간 할당을 자동으로 관리할 수 있습니다.

3.1. LVM 볼륨 그룹 생성

Cryostat create 명령을 사용하여 볼륨 그룹(VG)을 생성할 수 있습니다. 매우 크거나 매우 작은 볼륨의 범위 크기를 조정하여 성능 및 스토리지 효율성을 최적화할 수 있습니다. VG를 만들 때 범위 크기를 지정할 수 있습니다. 확장 범위를 변경하려면 볼륨 그룹을 다시 생성해야 합니다.

사전 요구 사항

- 관리 액세스.

-

lvm2패키지가 설치되어 있습니다. - 하나 이상의 물리 볼륨이 생성됩니다. 물리 볼륨 생성에 대한 자세한 내용은 LVM 물리 볼륨 생성 을 참조하십시오.

절차

VG에 포함할 PV를 나열하고 식별합니다.

pvs

# pvsCopy to Clipboard Copied! Toggle word wrap Toggle overflow VG를 만듭니다.

vgcreate VolumeGroupName PhysicalVolumeName1 PhysicalVolumeName2

# vgcreate VolumeGroupName PhysicalVolumeName1 PhysicalVolumeName2Copy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 생성하려는 볼륨 그룹의 이름으로 교체합니다. physicalVolumeName 을 PV 이름으로 교체합니다.

VG를 만들 때 확장 범위 크기를 지정하려면

-s ExtentSize옵션을 사용합니다. ExtentSize 를 extent의 크기로 바꿉니다. 크기 접미사를 제공하지 않으면 기본값은 MB입니다.

검증

VG가 생성되었는지 확인합니다.

vgs VG #PV #LV #SN Attr VSize VFree VolumeGroupName 1 0 0 wz--n- 28.87g 28.87g

# vgs VG #PV #LV #SN Attr VSize VFree VolumeGroupName 1 0 0 wz--n- 28.87g 28.87gCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.2. 웹 콘솔에서 볼륨 그룹 생성

하나 이상의 물리 드라이브 또는 기타 스토리지 장치에서 볼륨 그룹을 생성합니다.

논리 볼륨은 볼륨 그룹에서 생성됩니다. 각 볼륨 그룹에는 여러 논리 볼륨이 포함될 수 있습니다.

사전 요구 사항

- RHEL 9 웹 콘솔을 설치했습니다.

- cockpit 서비스를 활성화했습니다.

사용자 계정이 웹 콘솔에 로그인할 수 있습니다.

자세한 내용은 웹 콘솔 설치 및 활성화를 참조하십시오.

-

cockpit-storaged패키지가 시스템에 설치됩니다. - 볼륨 그룹을 생성할 물리 드라이브 또는 기타 유형의 스토리지 장치입니다.

절차

RHEL 9 웹 콘솔에 로그인합니다.

자세한 내용은 웹 콘솔에 로그인 을 참조하십시오.

- 스토리지를 .

- 스토리지 테이블에서 메뉴 버튼을 클릭합니다.

드롭다운 메뉴에서 LVM2 볼륨 그룹 만들기 를 선택합니다.

- 이름 필드에 볼륨 그룹의 이름을 입력합니다. 이름에는 공백을 포함할 수 없습니다.

결합할 드라이브를 선택하여 볼륨 그룹을 만듭니다.

RHEL 웹 콘솔은 사용되지 않는 블록 장치만 표시합니다. 장치가 목록에 표시되지 않는 경우 시스템에서 사용하지 않는지 확인하거나 비어 있고 사용되지 않도록 포맷합니다. 사용되는 장치는 예를 들면 다음과 같습니다.

- 파일 시스템으로 포맷된 장치

- 다른 볼륨 그룹의 물리 볼륨

- 물리 볼륨은 다른 소프트웨어 RAID 장치의 멤버입니다.

을 클릭합니다.

볼륨 그룹이 생성됩니다.

검증

- 스토리지 페이지에서 스토리지 테이블에 새 볼륨 그룹이 나열되어 있는지 확인합니다.

3.3. LVM 볼륨 그룹 이름 변경

Cryostat rename 명령을 사용하여 볼륨 그룹(VG)의 이름을 변경할 수 있습니다.

사전 요구 사항

- 관리 액세스.

-

lvm2패키지가 설치되어 있습니다. - 하나 이상의 물리 볼륨이 생성됩니다. 물리 볼륨 생성에 대한 자세한 내용은 LVM 물리 볼륨 생성 을 참조하십시오.

- 볼륨 그룹이 생성됩니다. 볼륨 그룹 생성에 대한 자세한 내용은 3.1절. “LVM 볼륨 그룹 생성” 을 참조하십시오.

절차

이름을 바꿀 VG를 나열하고 식별합니다.

vgs

# vgsCopy to Clipboard Copied! Toggle word wrap Toggle overflow VG의 이름을 변경합니다.

vgrename OldVolumeGroupName NewVolumeGroupName

# vgrename OldVolumeGroupName NewVolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow OldVolumeGroupName 을 VG의 이름으로 교체합니다. NewVolumeGroupName 을 VG의 새 이름으로 바꿉니다.

검증

VG에 새 이름이 있는지 확인합니다.

vgs VG #PV #LV #SN Attr VSize VFree NewVolumeGroupName 1 0 0 wz--n- 28.87g 28.87g

# vgs VG #PV #LV #SN Attr VSize VFree NewVolumeGroupName 1 0 0 wz--n- 28.87g 28.87gCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4. LVM 볼륨 그룹 확장

Cryostatextend 명령을 사용하여 PV(물리 볼륨)를 볼륨 그룹(VG)에 추가할 수 있습니다.

사전 요구 사항

- 관리 액세스.

-

lvm2패키지가 설치되어 있습니다. - 하나 이상의 물리 볼륨이 생성됩니다. 물리 볼륨 생성에 대한 자세한 내용은 LVM 물리 볼륨 생성 을 참조하십시오.

- 볼륨 그룹이 생성됩니다. 볼륨 그룹 생성에 대한 자세한 내용은 3.1절. “LVM 볼륨 그룹 생성” 을 참조하십시오.

절차

확장하려는 VG를 나열하고 식별합니다.

vgs

# vgsCopy to Clipboard Copied! Toggle word wrap Toggle overflow VG에 추가할 PV를 나열하고 식별합니다.

pvs

# pvsCopy to Clipboard Copied! Toggle word wrap Toggle overflow VG를 확장합니다.

vgextend VolumeGroupName PhysicalVolumeName

# vgextend VolumeGroupName PhysicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 VG의 이름으로 바꿉니다. physicalVolumeName 을 PV 이름으로 교체합니다.

검증

VG에 새 PV가 포함되어 있는지 확인합니다.

pvs PV VG Fmt Attr PSize PFree /dev/sda VolumeGroupName lvm2 a-- 28.87g 28.87g /dev/sdd VolumeGroupName lvm2 a-- 1.88g 1.88g

# pvs PV VG Fmt Attr PSize PFree /dev/sda VolumeGroupName lvm2 a-- 28.87g 28.87g /dev/sdd VolumeGroupName lvm2 a-- 1.88g 1.88gCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5. LVM 볼륨 그룹 결합

두 개의 기존 볼륨 그룹(VG)을 Cryostat merge 명령과 결합할 수 있습니다. 소스 볼륨이 대상 볼륨에 병합됩니다.

사전 요구 사항

- 관리 액세스.

-

lvm2패키지가 설치되어 있습니다. - 하나 이상의 물리 볼륨이 생성됩니다. 물리 볼륨 생성에 대한 자세한 내용은 LVM 물리 볼륨 생성 을 참조하십시오.

- 두 개 이상의 볼륨 그룹이 생성됩니다. 볼륨 그룹 생성에 대한 자세한 내용은 3.1절. “LVM 볼륨 그룹 생성” 을 참조하십시오.

절차

병합할 VG를 나열하고 식별합니다.

vgs VG #PV #LV #SN Attr VSize VFree VolumeGroupName1 1 0 0 wz--n- 28.87g 28.87g VolumeGroupName2 1 0 0 wz--n- 1.88g 1.88g

# vgs VG #PV #LV #SN Attr VSize VFree VolumeGroupName1 1 0 0 wz--n- 28.87g 28.87g VolumeGroupName2 1 0 0 wz--n- 1.88g 1.88gCopy to Clipboard Copied! Toggle word wrap Toggle overflow 소스 VG를 대상 VG에 병합합니다.

vgmerge VolumeGroupName2 VolumeGroupName1

# vgmerge VolumeGroupName2 VolumeGroupName1Copy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName2 를 소스 VG의 이름으로 교체합니다. VolumeGroupName1 을 대상 VG의 이름으로 바꿉니다.

검증

VG에 새 PV가 포함되어 있는지 확인합니다.

vgs VG #PV #LV #SN Attr VSize VFree VolumeGroupName1 2 0 0 wz--n- 30.75g 30.75g

# vgs VG #PV #LV #SN Attr VSize VFree VolumeGroupName1 2 0 0 wz--n- 30.75g 30.75gCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6. 볼륨 그룹에서 물리 볼륨 제거

볼륨 그룹(VG)에서 사용되지 않는 PV(물리 볼륨)를 제거하려면 Cryostatreduce 명령을 사용합니다. vgreduce 명령은 하나 이상의 빈 물리 볼륨을 제거하여 볼륨 그룹의 용량을 줄입니다. 이렇게 하면 물리 볼륨을 다른 볼륨 그룹에서 사용하거나 시스템에서 제거할 수 있습니다.

절차

물리 볼륨이 여전히 사용 중인 경우 동일한 볼륨 그룹에서 다른 물리 볼륨으로 데이터를 마이그레이션합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 기존 볼륨 그룹의 다른 물리 볼륨에 사용 가능한 확장 영역이 충분하지 않은 경우:

/dev/vdb4 에서 새 물리 볼륨을 생성합니다.

pvcreate /dev/vdb4 Physical volume "/dev/vdb4" successfully created

# pvcreate /dev/vdb4 Physical volume "/dev/vdb4" successfully createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow 새로 생성된 물리 볼륨을 볼륨 그룹에 추가합니다.

vgextend VolumeGroupName /dev/vdb4 Volume group "VolumeGroupName" successfully extended

# vgextend VolumeGroupName /dev/vdb4 Volume group "VolumeGroupName" successfully extendedCopy to Clipboard Copied! Toggle word wrap Toggle overflow /dev/vdb3에서 /dev/vdb 4 로 데이터를 이동합니다.

pvmove /dev/vdb3 /dev/vdb4 /dev/vdb3: Moved: 33.33% /dev/vdb3: Moved: 100.00%

# pvmove /dev/vdb3 /dev/vdb4 /dev/vdb3: Moved: 33.33% /dev/vdb3: Moved: 100.00%Copy to Clipboard Copied! Toggle word wrap Toggle overflow

볼륨 그룹에서 물리 볼륨 /dev/vdb3 을 제거합니다.

vgreduce VolumeGroupName /dev/vdb3 Removed "/dev/vdb3" from volume group "VolumeGroupName"

# vgreduce VolumeGroupName /dev/vdb3 Removed "/dev/vdb3" from volume group "VolumeGroupName"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

/dev/vdb3 물리 볼륨이 VolumeGroupName 볼륨 그룹에서 제거되었는지 확인합니다.

pvs PV VG Fmt Attr PSize PFree Used /dev/vdb1 VolumeGroupName lvm2 a-- 1020.00m 0 1020.00m /dev/vdb2 VolumeGroupName lvm2 a-- 1020.00m 0 1020.00m /dev/vdb3 lvm2 a-- 1020.00m 1008.00m 12.00m

# pvs PV VG Fmt Attr PSize PFree Used /dev/vdb1 VolumeGroupName lvm2 a-- 1020.00m 0 1020.00m /dev/vdb2 VolumeGroupName lvm2 a-- 1020.00m 0 1020.00m /dev/vdb3 lvm2 a-- 1020.00m 1008.00m 12.00mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.7. LVM 볼륨 그룹 분할

물리 볼륨에 사용되지 않은 공간이 충분한 경우 새 디스크를 추가하지 않고 새 볼륨 그룹을 만들 수 있습니다.

초기 설정에서 볼륨 그룹 VolumeGroupName1 은 /dev/vdb1,/dev/vdb2, /dev/vdb3 로 구성됩니다. 이 절차를 완료하면 볼륨 그룹 VolumeGroupName1 은 /dev/vdb1 및 /dev/vdb2 로 구성되며 두 번째 볼륨 그룹인 VolumeGroupName2 에서는 /dev/vdb3 로 구성됩니다.

사전 요구 사항

-

볼륨 그룹에 충분한 공간이 있습니다.

vgscan명령을 사용하여 현재 볼륨 그룹에서 사용할 수 있는 여유 공간을 결정합니다. -

기존 물리 볼륨의 사용 가능한 용량에 따라

pvmove명령을 사용하여 사용된 모든 물리 확장 영역을 다른 물리 볼륨으로 이동합니다. 자세한 내용은 볼륨 그룹에서 물리 볼륨 제거를 참조하십시오.

절차

기존 볼륨 그룹 VolumeGroupName1 을 새 볼륨 그룹 VolumeGroupName2 로 나눕니다.

vgsplit VolumeGroupName1 VolumeGroupName2 /dev/vdb3 Volume group "VolumeGroupName2" successfully split from "VolumeGroupName1"

# vgsplit VolumeGroupName1 VolumeGroupName2 /dev/vdb3 Volume group "VolumeGroupName2" successfully split from "VolumeGroupName1"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고기존 볼륨 그룹을 사용하여 논리 볼륨을 생성한 경우 다음 명령을 사용하여 논리 볼륨을 비활성화합니다.

lvchange -a n /dev/VolumeGroupName1/LogicalVolumeName

# lvchange -a n /dev/VolumeGroupName1/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 두 볼륨 그룹의 속성을 확인합니다.

vgs VG #PV #LV #SN Attr VSize VFree VolumeGroupName1 2 1 0 wz--n- 34.30G 10.80G VolumeGroupName2 1 0 0 wz--n- 17.15G 17.15G

# vgs VG #PV #LV #SN Attr VSize VFree VolumeGroupName1 2 1 0 wz--n- 34.30G 10.80G VolumeGroupName2 1 0 0 wz--n- 17.15G 17.15GCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

새로 생성된 볼륨 그룹 VolumeGroupName2 가 /dev/vdb3 물리 볼륨으로 구성되어 있는지 확인합니다.

pvs PV VG Fmt Attr PSize PFree Used /dev/vdb1 VolumeGroupName1 lvm2 a-- 1020.00m 0 1020.00m /dev/vdb2 VolumeGroupName1 lvm2 a-- 1020.00m 0 1020.00m /dev/vdb3 VolumeGroupName2 lvm2 a-- 1020.00m 1008.00m 12.00m

# pvs PV VG Fmt Attr PSize PFree Used /dev/vdb1 VolumeGroupName1 lvm2 a-- 1020.00m 0 1020.00m /dev/vdb2 VolumeGroupName1 lvm2 a-- 1020.00m 0 1020.00m /dev/vdb3 VolumeGroupName2 lvm2 a-- 1020.00m 1008.00m 12.00mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.8. 볼륨 그룹을 다른 시스템으로 이동

다음 명령을 사용하여 전체 LVM 볼륨 그룹(VG)을 다른 시스템으로 이동할 수 있습니다.

vgexport- 기존 시스템에서 이 명령을 사용하여 비활성 VG가 시스템에서 액세스할 수 없도록 합니다. VG에 액세스할 수 없게 되면 PV(물리 볼륨)를 분리할 수 있습니다.

vgimport- 다른 시스템에서 이 명령을 사용하여 이전 시스템에서 비활성화된 VG를 새 시스템에서 액세스할 수 있도록 합니다.

사전 요구 사항

- 이동 중인 볼륨 그룹의 활성 볼륨의 파일에 액세스 중인 사용자가 없습니다.

절차

LogicalVolumeName 논리 볼륨을 마운트 해제합니다.

umount /dev/mnt/LogicalVolumeName

# umount /dev/mnt/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 볼륨 그룹의 모든 논리 볼륨을 비활성화하여 볼륨 그룹의 추가 활동을 방지합니다.

vgchange -an VolumeGroupName vgchange -- volume group "VolumeGroupName" successfully deactivated

# vgchange -an VolumeGroupName vgchange -- volume group "VolumeGroupName" successfully deactivatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 볼륨 그룹을 내보내 제거 중인 시스템에서 액세스할 수 없도록 합니다.

vgexport VolumeGroupName vgexport -- volume group "VolumeGroupName" successfully exported

# vgexport VolumeGroupName vgexport -- volume group "VolumeGroupName" successfully exportedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 내보낸 볼륨 그룹을 확인합니다.

pvscan PV /dev/sda1 is in exported VG VolumeGroupName [17.15 GB / 7.15 GB free] PV /dev/sdc1 is in exported VG VolumeGroupName [17.15 GB / 15.15 GB free] PV /dev/sdd1 is in exported VG VolumeGroupName [17.15 GB / 15.15 GB free] ...

# pvscan PV /dev/sda1 is in exported VG VolumeGroupName [17.15 GB / 7.15 GB free] PV /dev/sdc1 is in exported VG VolumeGroupName [17.15 GB / 15.15 GB free] PV /dev/sdd1 is in exported VG VolumeGroupName [17.15 GB / 15.15 GB free] ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 시스템을 종료하고 볼륨 그룹을 구성하는 디스크를 분리하여 새 시스템에 연결합니다.

디스크를 새 시스템에 연결하고 볼륨 그룹을 가져와 새 시스템에서 액세스할 수 있도록 합니다.

vgimport VolumeGroupName

# vgimport VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고Cryostat

import명령의--force인수를 사용하여 물리 볼륨이 누락된 볼륨 그룹을 가져와서 나중에--removemissing명령을 실행할 수 있습니다.볼륨 그룹을 활성화합니다.

vgchange -ay VolumeGroupName

# vgchange -ay VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일 시스템을 마운트하여 사용할 수 있도록 합니다.

mkdir -p /mnt/VolumeGroupName/users mount /dev/VolumeGroupName/users /mnt/VolumeGroupName/users

# mkdir -p /mnt/VolumeGroupName/users # mount /dev/VolumeGroupName/users /mnt/VolumeGroupName/usersCopy to Clipboard Copied! Toggle word wrap Toggle overflow

추가 리소스

-

시스템의 Cryostatimport(8), Cryostatexport(8), and Cryostatchange(8)매뉴얼 페이지

3.9. LVM 볼륨 그룹 제거

Cryostatremove 명령을 사용하여 기존 볼륨 그룹을 제거할 수 있습니다. 논리 볼륨이 포함되지 않은 볼륨 그룹만 제거할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

볼륨 그룹에 논리 볼륨이 포함되어 있지 않은지 확인합니다.

vgs -o vg_name,lv_count VolumeGroupName VG #LV VolumeGroupName 0

# vgs -o vg_name,lv_count VolumeGroupName VG #LV VolumeGroupName 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다.

볼륨 그룹 제거:

vgremove VolumeGroupName

# vgremove VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다.

3.10. 클러스터 환경에서 LVM 볼륨 그룹 제거

클러스터 환경에서 LVM은 lockspace <qualifier>를 사용하여 여러 시스템에서 공유되는 볼륨 그룹에 대한 액세스를 조정합니다. 제거 프로세스 중에 다른 노드에 액세스하거나 수정하지 않으려면 볼륨 그룹을 제거하기 전에 잠금 공간을 중지해야 합니다.

사전 요구 사항

- 관리 액세스.

- 볼륨 그룹에 논리 볼륨이 없습니다.

절차

볼륨 그룹에 논리 볼륨이 포함되어 있지 않은지 확인합니다.

vgs -o vg_name,lv_count VolumeGroupName VG #LV VolumeGroupName 0

# vgs -o vg_name,lv_count VolumeGroupName VG #LV VolumeGroupName 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다.

볼륨 그룹을 제거하는 노드를 제외한 모든 노드에서

잠금 공간을중지합니다.vgchange --lockstop VolumeGroupName

# vgchange --lockstop VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 바꾸고 잠금이 중지될 때까지 기다립니다.

볼륨 그룹 제거:

vgremove VolumeGroupName

# vgremove VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다.

4장. 기본 논리 볼륨 관리

LVM을 사용하면 다음 작업을 수행할 수 있습니다.

- 시스템의 스토리지 기능을 확장하기 위해 새 논리 볼륨 생성

- 기존 볼륨 및 씬 풀을 확장하여 증가하는 데이터를 수용합니다.

- 더 나은 조직을 위해 볼륨 이름 변경

- 사용되지 않는 공간을 확보하기 위해 볼륨 감소

- 더 이상 필요하지 않을 때 볼륨을 안전하게 제거

- 볼륨 활성화 또는 비활성화하여 시스템의 데이터 액세스를 제어

4.1. 논리 볼륨 기능 개요

LVM(Logical Volume Manager)을 사용하면 기존 파티션 체계에서 제공할 수 없는 유연하고 효율적인 방식으로 디스크 스토리지를 관리할 수 있습니다. 다음은 스토리지 관리 및 최적화에 사용되는 주요 LVM 기능에 대한 요약입니다.

- 연결

- 연결에는 하나 이상의 물리 볼륨의 공간을 단일 논리 볼륨으로 결합하여 물리적 스토리지를 효과적으로 병합해야 합니다.

- 스트라이핑

- 스트라이핑은 여러 물리 볼륨에 데이터를 분산하여 데이터 I/O 효율성을 최적화합니다. 이 방법은 병렬 I/O 작업을 허용하여 순차적 읽기 및 쓰기에 대한 성능을 향상시킵니다.

- RAID

- LVM은 RAID 레벨 0, 1, 4, 5, 6, 10을 지원합니다. RAID 논리 볼륨을 생성하면 LVM에서 배열의 모든 데이터 또는 패리티 하위 볼륨에 대해 크기가 1개인 메타데이터 하위 볼륨을 생성합니다.

- 씬 프로비저닝

- 씬 프로비저닝을 사용하면 사용 가능한 물리 스토리지보다 큰 논리 볼륨을 생성할 수 있습니다. 씬 프로비저닝을 사용하면 시스템에서 사전 결정된 양을 미리 할당하는 대신 실제 사용량에 따라 스토리지를 동적으로 할당합니다.

- 스냅샷

- LVM 스냅샷을 사용하면 논리 볼륨의 지정 시간 사본을 생성할 수 있습니다. 스냅샷은 비어 있습니다. 원래 논리 볼륨에서 변경 사항이 발생하면 스냅샷은 COW(Copy-On-Write)를 통해 사전 변경 상태를 캡처하여 원래 논리 볼륨의 상태를 유지하기 위한 변경 사항만 늘립니다.

- 캐싱

- LVM에서는 느린 큰 블록 장치에 대해 SSD 드라이브와 같은 빠른 블록 장치의 사용을 지원합니다. 사용자는 캐시 논리 볼륨을 생성하여 기존 논리 볼륨의 성능을 향상하거나 크고 느린 장치에 연결된 소형 및 빠른 장치로 구성된 새 캐시 논리 볼륨을 생성할 수 있습니다.

4.2. 논리 볼륨 생성

LVM은 물리적 계층을 필요에 따라 생성하고 조정할 수 있는 논리 볼륨으로 추상화하여 디스크 스토리지를 처리할 수 있는 유연한 접근 방식을 제공합니다.

4.2.1. 선형(thick) 논리 볼륨 생성

선형 논리 볼륨(LV)을 사용하면 여러 물리적 스토리지 단위를 하나의 가상 스토리지 공간에 병합할 수 있습니다. 선형 LV를 쉽게 확장하거나 줄여 데이터 요구 사항을 충족할 수 있습니다.

사전 요구 사항

- 관리 액세스.

-

lvm2패키지가 설치되어 있습니다. - 볼륨 그룹이 생성됩니다. 자세한 내용은 LVM 볼륨 그룹 생성을 참조하십시오.

절차

볼륨 그룹의 이름과 크기를 나열합니다.

vgs -o vg_name,vg_size VG VSize VolumeGroupName 30.75g

# vgs -o vg_name,vg_size VG VSize VolumeGroupName 30.75gCopy to Clipboard Copied! Toggle word wrap Toggle overflow 선형 LV를 만듭니다.

lvcreate --name LogicalVolumeName --size VolumeSize VolumeGroupName

# lvcreate --name LogicalVolumeName --size VolumeSize VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow LogicalVolumeName 을 LV의 이름으로 바꿉니다. VolumeSize 를 LV의 크기로 바꿉니다. 크기 접미사가 제공되지 않은 경우 명령은 기본적으로 MB로 설정됩니다. VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다.

검증

선형 LV가 생성되었는지 확인합니다.

lvs -o lv_name,seg_type LV Type LogicalVolumeName linear

# lvs -o lv_name,seg_type LV Type LogicalVolumeName linearCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.2. 스토리지 RHEL 시스템 역할을 사용하여 논리 볼륨 생성 또는 크기 조정

스토리지 역할을 사용하여 다음 작업을 수행합니다.

- 여러 디스크로 구성된 볼륨 그룹에 LVM 논리 볼륨을 만들려면 다음을 수행합니다.

- LVM에서 기존 파일 시스템의 크기를 조정하려면 다음을 수행합니다.

- 풀의 총 크기의 백분율로 LVM 볼륨 크기를 표현하려면

볼륨 그룹이 없으면 역할이 생성됩니다. 논리 볼륨이 볼륨 그룹에 있는 경우 크기가 플레이북에 지정된 것과 일치하지 않으면 크기가 조정됩니다.

논리 볼륨을 줄이는 경우 데이터 손실을 방지하기 위해 논리 볼륨의 파일 시스템이 축소되는 논리 볼륨의 공간을 사용하지 않도록 해야 합니다.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다.

절차

다음 콘텐츠를 사용하여 플레이북 파일(예:

~/playbook.yml)을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제 플레이북에 지정된 설정은 다음과 같습니다.

크기: < ;size>- 단위(예: GiB) 또는 백분율(예: 60 %)을 사용하여 크기를 지정해야 합니다.

플레이북에 사용되는 모든 변수에 대한 자세한 내용은 제어 노드의

/usr/share/ansible/roles/rhel-system-roles.storage/README.md파일을 참조하십시오.플레이북 구문을 확인합니다.

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

지정된 볼륨이 요청된 크기로 생성되거나 크기가 조정되었는지 확인합니다.

ansible managed-node-01.example.com -m command -a 'lvs myvg'

# ansible managed-node-01.example.com -m command -a 'lvs myvg'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.3. 제거된 논리 볼륨 생성

제거된 논리 볼륨(LV)을 사용하면 여러 PV(물리 볼륨)에 데이터를 배포할 수 있으므로 여러 디스크의 대역폭을 동시에 사용하여 읽기 및 쓰기 속도를 높일 수 있습니다.

스트라이핑된 LV를 만들 때는 스트라이프 번호와 크기를 고려해야 합니다. 스트라이프 번호는 데이터가 배포되는 PV 수입니다. 스트라이프 번호를 늘리면 동시에 여러 디스크를 사용하여 성능을 향상시킬 수 있습니다. 스트라이프 크기는 다음 디스크로 이동하기 전에 설정된 스트라이프 세트의 각 디스크에 기록된 데이터 청크의 크기이며 킬로바이트(KB)로 지정됩니다. 최적의 스트라이프 크기는 워크로드 및 파일 시스템 블록 크기에 따라 다릅니다. 기본값은 64KB이며 조정할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

볼륨 그룹의 이름과 크기를 나열합니다.

vgs -o vg_name,vg_size VG VSize VolumeGroupName 30.75g

# vgs -o vg_name,vg_size VG VSize VolumeGroupName 30.75gCopy to Clipboard Copied! Toggle word wrap Toggle overflow 제거된 LV를 생성합니다.

lvcreate --stripes NumberOfStripes --stripesize StripeSize --size LogicalVolumeSize --name LogicalVolumeName VolumeGroupName

# lvcreate --stripes NumberOfStripes --stripesize StripeSize --size LogicalVolumeSize --name LogicalVolumeName VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow NumberOfStripes 를 스트라이프 수로 바꿉니다. StripeSize 를 킬라이프 크기(KB)로 바꿉니다.

--stripesize는 필수 옵션이 아닙니다. 스트라이프 크기를 지정하지 않으면 기본값은 64KB입니다. LogicalVolumeName 을 LV의 이름으로 바꿉니다. VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다.

검증

제거된 LV가 생성되었는지 확인합니다.

lvs -o lv_name,seg_type LV Type LogicalVolumeName striped

# lvs -o lv_name,seg_type LV Type LogicalVolumeName stripedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.4. RAID 논리 볼륨 생성

RAID 논리 볼륨을 사용하면 중복 및 성능을 위해 여러 디스크를 사용할 수 있습니다. LVM은 RAID0, RAID1, RAID4, RAID5, RAID6, RAID10을 비롯한 다양한 RAID 수준을 지원합니다.

LVM을 사용하면 스트라이핑된 RAID(RAID0, RAID4, RAID5, RAID6), 미러링된 RAID(RAID1) 또는 둘 다의 조합을 생성할 수 있습니다.

RAID 4, RAID 5 및 RAID 6은 디스크 장애 발생 시 손실된 정보를 재구성하는 데 사용할 수 있는 패리티 데이터를 저장하여 내결함성을 제공합니다.

RAID LV를 생성할 때 각 스트라이프를 별도의 PV에 배치합니다. 볼륨 그룹(VG)에 있어야 하는 PV 수와 동일한 스트라이프 수입니다.

| RAID 수준 | 유형 | 패리티 | 최소 장치 수 | 최소 스트라이프 번호 |

|---|---|---|---|---|

| RAID0 | 스트라이핑 | 없음 | 2 | 2 |

| RAID1 | 미러링 | 없음 | 2 | - |

| RAID4 | 스트라이핑 | 첫 번째 장치를 사용하여 패리티 저장 | 3 | 2 |

| RAID5 | 스트라이핑 | 추가 장치를 사용하여 패리티 저장 | 3 | 2 |

| RAID6 | 스트라이핑 | 두 개의 추가 장치를 사용하여 패리티 저장 | 5 | 3 |

| RAID10 | 제거 및 미러링 | 없음 | 4 | 2 |

사전 요구 사항

- 관리 액세스.

절차

볼륨 그룹의 이름과 크기를 나열합니다.

vgs -o vg_name,vg_size VG VSize VolumeGroupName 30.75g

# vgs -o vg_name,vg_size VG VSize VolumeGroupName 30.75gCopy to Clipboard Copied! Toggle word wrap Toggle overflow RAID LV를 생성합니다.

제거된 raid를 생성하려면 다음을 사용합니다.

lvcreate --type raidlevel --stripes NumberOfStripes --stripesize StripeSize --size Size --name LogicalVolumeName VolumeGroupName

# lvcreate --type raidlevel --stripes NumberOfStripes --stripesize StripeSize --size Size --name LogicalVolumeName VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 수준을 RAID 수준 0, 4, 5 또는 6으로 바꿉니다. NumberOfStripes 를 스트라이프 수로 바꿉니다. StripeSize 를 킬라이프 크기(KB)로 바꿉니다. Size 를 LV의 크기로 바꿉니다. LogicalVolumeName 을 LV의 이름으로 바꿉니다.

미러링된 RAID를 생성하려면 다음을 사용합니다.

lvcreate --type raid1 --mirrors MirrorsNumber --size Size --name LogicalVolumeName VolumeGroupName

# lvcreate --type raid1 --mirrors MirrorsNumber --size Size --name LogicalVolumeName VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow MirrorsNumber 를 미러 수로 바꿉니다. Size 를 LV의 크기로 바꿉니다. LogicalVolumeName 을 LV의 이름으로 바꿉니다.

미러링 및 스트라이핑된 RAID를 생성하려면 다음을 사용합니다.

lvcreate --type raid10 --mirrors MirrorsNumber --stripes NumberOfStripes --stripesize StripeSize --size Size --name LogicalVolumeName VolumeGroupName

# lvcreate --type raid10 --mirrors MirrorsNumber --stripes NumberOfStripes --stripesize StripeSize --size Size --name LogicalVolumeName VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow MirrorsNumber 를 미러 수로 바꿉니다. NumberOfStripes 를 스트라이프 수로 바꿉니다. StripeSize 를 킬라이프 크기(KB)로 바꿉니다. Size 를 LV의 크기로 바꿉니다. LogicalVolumeName 을 LV의 이름으로 바꿉니다.

검증

RAID LV가 생성되었는지 확인합니다.

lvs -o lv_name,seg_type LV Type LogicalVolumeName raid0

# lvs -o lv_name,seg_type LV Type LogicalVolumeName raid0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.5. thin 논리 볼륨 생성

씬 프로비저닝에서는 볼륨 그룹(VG)의 물리 확장 영역(PE)이 할당되어 특정 물리 크기가 있는 씬 풀을 생성합니다. 그런 다음 LV(논리 볼륨)는 풀의 물리 용량에 국한되지 않고 가상 크기를 기반으로 이 씬 풀에서 할당됩니다. 이를 통해 씬 풀의 실제 크기를 초과하여 모든 씬 LV의 집합적인 가상 크기가 씬 풀의 물리적 용량을 초과하면 씬 풀의 실제 크기를 초과할 수 있습니다. 따라서 공간과 중단이 발생하지 않도록 논리 및 물리적 사용을 모두 모니터링하는 것이 중요합니다.

씬 프로비저닝은 공간을 할당하고 초기 비용을 낮추고 리소스 사용률을 개선하여 스토리지 효율성을 최적화합니다. 그러나 thin LV를 사용하는 경우 다음과 같은 단점이 있습니다.

- 부적절한 삭제 처리는 사용되지 않는 스토리지 공간의 릴리스를 차단하여 시간이 지남에 따라 공간을 완전히 할당할 수 있습니다.

- 쓰기(CoW) 작업의 복사는 스냅샷을 사용하여 파일 시스템에서 느려질 수 있습니다.

- 데이터 블록은 여러 파일 시스템 간에 혼합되어 임의 액세스 제한이 있을 수 있습니다.

사전 요구 사항

- 관리 액세스.

- 물리 볼륨이 생성되어 있습니다. 자세한 내용은 LVM 물리 볼륨 생성 을 참조하십시오.

- 볼륨 그룹을 생성했습니다. 자세한 내용은 LVM 볼륨 그룹 생성을 참조하십시오.

- 논리 볼륨을 생성했습니다. 자세한 내용은 논리 볼륨 생성 을 참조하십시오.

절차

볼륨 그룹의 이름과 크기를 나열합니다.

vgs -o vg_name,vg_size VG VSize VolumeGroupName 30.75g

# vgs -o vg_name,vg_size VG VSize VolumeGroupName 30.75gCopy to Clipboard Copied! Toggle word wrap Toggle overflow 씬 풀을 생성합니다.

lvcreate --type thin-pool --size PoolSize --name ThinPoolName VolumeGroupName

# lvcreate --type thin-pool --size PoolSize --name ThinPoolName VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow PoolSize 를 thin pool에서 사용할 수 있는 최대 디스크 공간으로 바꿉니다. ThinPoolName 을 thin 풀의 이름으로 바꿉니다. VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다.

thin LV를 만듭니다.

lvcreate --type thin --virtualsize MaxVolumeSize --name ThinVolumeName --thinpool ThinPoolName VolumeGroupName

# lvcreate --type thin --virtualsize MaxVolumeSize --name ThinVolumeName --thinpool ThinPoolName VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow MaxVolumeSize 를 씬 풀 내에서 볼륨의 최대 크기로 바꿉니다. ThinPoolName 을 thin 풀의 이름으로 바꿉니다. VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다.

참고동일한 씬 풀 내에 다른 thin LV를 생성할 수 있습니다.

검증

thin LV가 생성되었는지 확인합니다.

lvs -o lv_name,seg_type LV Type ThinPoolName thin-pool ThinVolumeName thin

# lvs -o lv_name,seg_type LV Type ThinPoolName thin-pool ThinVolumeName thinCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.6. VDO 논리 볼륨 생성

VDO 논리 볼륨(LV)은 VDO(Virtual Data Optimizer) 기술을 사용하여 스토리지 효율성을 향상시킵니다. VDO LVs에는 가상 크기와 물리적 크기가 모두 있습니다. 가상 크기는 사용자 및 애플리케이션에 제공되는 총 스토리지 양을 나타냅니다. 물리적 크기는 VG에서 할당되고 VDO 풀에서 사용하는 실제 스토리지의 실제 양입니다.

VDO LV의 가상 크기는 일반적으로 VDO 풀의 물리적 크기보다 크므로 과도하게 프로비저닝됩니다. VDO 풀의 물리적 공간을 과도하게 프로비저닝하므로 필요한 경우 적극적으로 모니터링 및 확장해야 합니다.

VDO LV 및 VDO 풀은 쌍으로 생성되며 항상 쌍으로 존재합니다.

사전 요구 사항

- 관리 액세스.

절차

볼륨 그룹의 이름과 크기를 나열합니다.

vgs -o vg_name,vg_size VG VSize VolumeGroupName 30.75g

# vgs -o vg_name,vg_size VG VSize VolumeGroupName 30.75gCopy to Clipboard Copied! Toggle word wrap Toggle overflow VDO LV를 생성합니다.

lvcreate --type vdo --virtualsize VolumeSize --size PhysicalPoolSize --name VDOVolumeName --vdopool VDOPoolName VolumeGroupName

# lvcreate --type vdo --virtualsize VolumeSize --size PhysicalPoolSize --name VDOVolumeName --vdopool VDOPoolName VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeSize 를 볼륨의 크기로 바꿉니다. PhysicalPoolSize 를 풀의 크기로 바꿉니다. VDOVolumeName 을 VDO 볼륨의 이름으로 바꿉니다. VDOPoolName 을 VDO 풀의 이름으로 바꿉니다. VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다.

검증

VDO LV가 생성되었는지 확인합니다.

lvs -o name,seg_type,size LV Type LSize VDOPoolName vdo-pool 5.00g VDOVolumeName vdo 5.00g

# lvs -o name,seg_type,size LV Type LSize VDOPoolName vdo-pool 5.00g VDOVolumeName vdo 5.00gCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3. 논리 볼륨 크기 조정

LVM(Logical Volume Manager)을 사용하면 저장된 데이터에 영향을 주지 않고 필요에 따라 논리 볼륨(LV)의 크기를 조정할 수 있습니다.

4.3.1. 선형 논리 볼륨 확장

lvextend 명령을 사용하여 선형(thick) LV 및 해당 스냅샷을 확장할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

볼륨 그룹에 LV를 확장할 수 있는 충분한 공간이 있는지 확인합니다.

lvs -o lv_name,lv_size,vg_name,vg_size,vg_free LV LSize VG VSize VFree LogicalVolumeName 1.49g VolumeGroupName 30.75g 29.11g

# lvs -o lv_name,lv_size,vg_name,vg_size,vg_free LV LSize VG VSize VFree LogicalVolumeName 1.49g VolumeGroupName 30.75g 29.11gCopy to Clipboard Copied! Toggle word wrap Toggle overflow 선형 LV를 확장하고 파일 시스템의 크기를 조정합니다.

lvextend --size +AdditionalSize --resizefs VolumeGroupName/LogicalVolumeName

# lvextend --size +AdditionalSize --resizefs VolumeGroupName/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow additional Size 를 LV에 추가할 공백으로 바꿉니다. 기본 측정 단위는 메가바이트이지만 다른 단위를 지정할 수 있습니다. VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. LogicalVolumeName 을 thin 볼륨의 이름으로 바꿉니다.

검증

선형 LV가 확장되었는지 확인합니다.

lvs -o lv_name,lv_size LV LSize NewLogicalVolumeName 6.49g

# lvs -o lv_name,lv_size LV LSize NewLogicalVolumeName 6.49gCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3.2. thin 논리 볼륨 확장

lvextend 명령을 사용하여 thin 논리 볼륨(LV)을 확장할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

씬 풀에 추가할 데이터에 충분한 공간이 있는지 확인합니다.

lvs -o lv_name,lv_size,data_percent LV LSize Data% MyThinPool 20.10g 3.21 ThinVolumeName 1.10g 4.88

# lvs -o lv_name,lv_size,data_percent LV LSize Data% MyThinPool 20.10g 3.21 ThinVolumeName 1.10g 4.88Copy to Clipboard Copied! Toggle word wrap Toggle overflow thin LV를 확장하고 파일 시스템의 크기를 조정합니다.

lvextend --size +AdditionalSize --resizefs VolumeGroupName/ThinVolumeName

# lvextend --size +AdditionalSize --resizefs VolumeGroupName/ThinVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow additional Size 를 LV에 추가할 공백으로 바꿉니다. 기본 측정 단위는 메가바이트이지만 다른 단위를 지정할 수 있습니다. VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. ThinVolumeName 을 thin 볼륨의 이름으로 바꿉니다.

검증

thin LV가 확장되었는지 확인합니다.

lvs -o lv_name,lv_size,data_percent LV LSize Data% MyThinPool 20.10g 3.21 ThinVolumeName 6.10g 0.43

# lvs -o lv_name,lv_size,data_percent LV LSize Data% MyThinPool 20.10g 3.21 ThinVolumeName 6.10g 0.43Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3.3. 씬 풀 확장

thin 논리 볼륨의 가상 크기는 씬 풀의 물리적 용량을 초과하여 과도하게 프로비저닝할 수 있습니다. 공간이 부족하지 않도록 하려면 씬 풀의 용량을 모니터링하고 주기적으로 확장해야 합니다.

data_percent 메트릭은 현재 씬 풀이 사용하는 할당된 데이터 공간의 백분율을 나타냅니다. metadata_percent 지표는 메타데이터를 저장하는 데 사용되는 공간의 백분율을 반영합니다. 이는 씬 풀 내의 매핑을 관리하는 데 중요합니다.

이러한 메트릭을 모니터링하는 것은 효율적인 스토리지 관리를 보장하고 용량 문제를 방지하는 데 중요합니다.

LVM은 필요에 따라 데이터 또는 메타데이터 용량을 수동으로 확장하는 옵션을 제공합니다. 또는 씬 풀의 확장을 모니터링하고 자동화할 수 있습니다.

4.3.3.1. 수동으로 씬 풀 확장

LVM(Logical Volume Manager)은 데이터 세그먼트, 메타데이터 세그먼트 또는 씬 풀을 수동으로 확장하는 옵션을 제공합니다.

4.3.3.1.1. 씬 풀 확장

lvextend 명령을 사용하여 thin 풀을 확장할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

사용된 데이터 및 메타데이터 공간을 표시합니다.

lvs -o lv_name,seg_type,data_percent,metadata_percent LV Type Data% Meta% ThinPoolName thin-pool 97.66 26.86 ThinVolumeName thin 48.80

# lvs -o lv_name,seg_type,data_percent,metadata_percent LV Type Data% Meta% ThinPoolName thin-pool 97.66 26.86 ThinVolumeName thin 48.80Copy to Clipboard Copied! Toggle word wrap Toggle overflow thin 풀을 확장합니다.

lvextend -L Size VolumeGroupName/ThinPoolName

# lvextend -L Size VolumeGroupName/ThinPoolNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow thin pool의 새 크기로 Size 를 바꿉니다. VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. ThinPoolName 을 thin 풀 이름으로 교체합니다.

데이터 크기가 확장됩니다. 필요한 경우 메타데이터 크기가 확장됩니다.

검증

thin 풀이 확장되었는지 확인합니다.

lvs -o lv_name,seg_type,data_percent,metadata_percent LV Type Data% Meta% ThinPoolName thin-pool 24.41 16.93 ThinVolumeName thin 24.41

# lvs -o lv_name,seg_type,data_percent,metadata_percent LV Type Data% Meta% ThinPoolName thin-pool 24.41 16.93 ThinVolumeName thin 24.41Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3.3.1.2. 씬 풀 데이터 세그먼트 확장

lvextend 명령을 사용하여 data_percent 세그먼트를 확장할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

data_percent세그먼트를 표시합니다.lvs -o lv_name,seg_type,data_percent LV Type Data% ThinPoolName thin-pool 93.87

# lvs -o lv_name,seg_type,data_percent LV Type Data% ThinPoolName thin-pool 93.87Copy to Clipboard Copied! Toggle word wrap Toggle overflow data_percent세그먼트를 확장합니다.lvextend -L Size VolumeGroupName/ThinPoolName_tdata

# lvextend -L Size VolumeGroupName/ThinPoolName_tdataCopy to Clipboard Copied! Toggle word wrap Toggle overflow Size 를 데이터 세그먼트의 크기로 바꿉니다. VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. ThinPoolName 을 thin 풀 이름으로 교체합니다.

검증

data_percent세그먼트가 확장되었는지 확인합니다.lvs -o lv_name,seg_type,data_percent LV Type Data% ThinPoolName thin-pool 40.23

# lvs -o lv_name,seg_type,data_percent LV Type Data% ThinPoolName thin-pool 40.23Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3.3.1.3. 씬 풀 메타데이터 세그먼트 확장

lvextend 명령을 사용하여 metadata_percent 세그먼트를 확장할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

metadata_percent세그먼트를 표시합니다.lvs -o lv_name,seg_type,metadata_percent LV Type Meta% ThinPoolName thin-pool 75.00

# lvs -o lv_name,seg_type,metadata_percent LV Type Meta% ThinPoolName thin-pool 75.00Copy to Clipboard Copied! Toggle word wrap Toggle overflow metadata_percent세그먼트를 확장합니다.lvextend -L Size VolumeGroupName/ThinPoolName_tmeta

# lvextend -L Size VolumeGroupName/ThinPoolName_tmetaCopy to Clipboard Copied! Toggle word wrap Toggle overflow Size 를 메타데이터 세그먼트의 크기로 바꿉니다. VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. ThinPoolName 을 thin 풀 이름으로 교체합니다.

검증

metadata_percent세그먼트가 확장되었는지 확인합니다.lvs -o lv_name,seg_type,metadata_percent LV Type Meta% ThinPoolName thin-pool 0.19

# lvs -o lv_name,seg_type,metadata_percent LV Type Meta% ThinPoolName thin-pool 0.19Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3.3.2. 씬 풀 자동 확장

thin_pool_autoextend_threshold 및 thin_pool_autoextend_percent 구성 매개변수를 모니터링하고 설정하여 씬 풀 확장을 자동화할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

thin 풀이 모니터링되는지 확인합니다.

lvs -o lv_name,vg_name,seg_monitor LV VG Monitor ThinPoolName VolumeGroupName not monitored

# lvs -o lv_name,vg_name,seg_monitor LV VG Monitor ThinPoolName VolumeGroupName not monitoredCopy to Clipboard Copied! Toggle word wrap Toggle overflow dmeventd데몬을 사용하여 thin pool 모니터링을 활성화합니다.lvchange --monitor y VolumeGroupName/ThinPoolName

# lvchange --monitor y VolumeGroupName/ThinPoolNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. ThinPoolName 을 thin 풀 이름으로 교체합니다.

-

root사용자로 선택한 편집기에서/etc/lvm/lvm.conf파일을 엽니다. thin_pool_autoextend_threshold및thin_pool_autoextend_percent행의 주석을 제거하고 각 매개변수를 필수 값으로 설정합니다.thin_pool_autoextend_threshold = 70 thin_pool_autoextend_percent = 20

thin_pool_autoextend_threshold = 70 thin_pool_autoextend_percent = 20Copy to Clipboard Copied! Toggle word wrap Toggle overflow thin_pool_autoextend_threshold는 LVM이 씬 풀을 자동 확장하기 시작하는 백분율을 결정합니다. 예를 들어, 이를 70개로 설정하면 LVM이 70% 용량에 도달하면 LVM에서 씬 풀을 확장하려고 합니다.thin_pool_autoextend_percent는 임계값에 도달할 때 씬 풀을 확장해야 하는 백분율을 지정합니다. 예를 들어 20으로 설정하면 씬 풀이 현재 크기의 20% 증가합니다.- 변경 사항을 저장하고 편집기를 종료합니다.

lvm2-monitor를 다시 시작하십시오.systemctl restart lvm2-monitor

# systemctl restart lvm2-monitorCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3.4. VDO 풀 확장

공간 부족을 방지하기 위해 VDO 풀의 용량을 모니터링하고 주기적으로 확장하는 것이 중요합니다.

LVM(Logical Volume Manager)은 필요에 따라 VDO 풀 용량을 수동으로 확장하는 옵션을 제공합니다. 또는 모니터링을 활성화하고 VDO 풀의 확장을 자동화할 수 있습니다.

4.3.4.1. 수동으로 VDO 풀 확장

lvextend 명령을 사용하여 VDO 풀을 확장합니다.

사전 요구 사항

- 관리 액세스.

절차

현재 VDO 사용을 표시합니다.

lvs -o lv_name,vg_name,lv_size,data_percent VolumeGroupName/VDOPoolName LV VG LSize Data% VDOPoolName VolumeGroupName 5.00g 60.03

# lvs -o lv_name,vg_name,lv_size,data_percent VolumeGroupName/VDOPoolName LV VG LSize Data% VDOPoolName VolumeGroupName 5.00g 60.03Copy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. VDOPoolName 을 VDO 풀의 이름으로 바꿉니다.

VDO 풀을 확장합니다.

lvextend --size PhysicalSize VolumeGroupName/VDOPoolName

# lvextend --size PhysicalSize VolumeGroupName/VDOPoolNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow physicalSize 를 새 물리 크기로 바꿉니다. VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. VDOPoolName 을 VDO 풀의 이름으로 바꿉니다.

검증

VDO 풀이 확장되었는지 확인합니다.

lvs -o lv_name,vg_name,lv_size,data_percent VolumeGroupName/VDOPoolName LV VG LSize Data% VDOPoolName VolumeGroupName 10.00g 30.02

# lvs -o lv_name,vg_name,lv_size,data_percent VolumeGroupName/VDOPoolName LV VG LSize Data% VDOPoolName VolumeGroupName 10.00g 30.02Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3.4.2. VDO 풀 자동 확장

모니터링을 활성화하고 vdo_pool_autoextend_threshold 및 vdo_pool_autoextend_percent 매개변수를 설정하여 VDO(Virtual Data Optimizer) 풀 확장을 자동화할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

VDO 풀이 모니터링되는지 확인합니다.

lvs -o name,seg_monitor VolumeGroupName/VDOPoolName LV VG Monitor VDOPoolName VolumeGroupName not monitored

# lvs -o name,seg_monitor VolumeGroupName/VDOPoolName LV VG Monitor VDOPoolName VolumeGroupName not monitoredCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. VDOPoolName 을 VDO 풀의 이름으로 바꿉니다.

dmeventd데몬을 사용하여 VDO 풀 모니터링을 활성화합니다.lvchange --monitor y VolumeGroupName/VDOPoolName

# lvchange --monitor y VolumeGroupName/VDOPoolNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. VDOPoolName 을 VDO 풀의 이름으로 바꿉니다.

-

root사용자로 선택한 편집기에서/etc/lvm/lvm.conf파일을 엽니다. vdo_pool_autoextend_percent및vdo_pool_autoextend_threshold행의 주석을 제거하고 각 매개변수를 필수 값으로 설정합니다.vdo_pool_autoextend_threshold = 70 vdo_pool_autoextend_percent = 20

vdo_pool_autoextend_threshold = 70 vdo_pool_autoextend_percent = 20Copy to Clipboard Copied! Toggle word wrap Toggle overflow vdo_pool_autoextend_threshold는 LVM이 VDO 풀을 자동 연장하기 시작하는 백분율을 결정합니다. 예를 들어, 이를 70개로 설정하면 LVM에서 VDO 풀을 70% 용량에 도달할 때 확장하려고 합니다.vdo_pool_autoextend_percent는 threshold에 도달할 때 VDO 풀을 확장해야 하는 백분율로 지정합니다. 예를 들어 20으로 설정하면 VDO 풀이 현재 크기의 20% 증가합니다.- 변경 사항을 저장하고 편집기를 종료합니다.

lvm2-monitor를 다시 시작하십시오.systemctl restart lvm2-monitor

# systemctl restart lvm2-monitorCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3.5. 논리 볼륨 축소

LV의 크기가 감소되면 사용 가능한 논리 확장 영역이 볼륨 그룹으로 반환되고 다른 LV에서 사용할 수 있습니다.

축소된 영역에 저장된 데이터가 손실됩니다. 계속하기 전에 항상 데이터를 백업하고 파일 시스템의 크기를 조정합니다.

사전 요구 사항

- 관리 액세스.

절차

논리 볼륨 및 해당 볼륨 그룹을 나열합니다.

lvs -o lv_name,vg_name,lv_size LV VG LSize LogicalVolumeName VolumeGroupName 6.49g

# lvs -o lv_name,vg_name,lv_size LV VG LSize LogicalVolumeName VolumeGroupName 6.49gCopy to Clipboard Copied! Toggle word wrap Toggle overflow 논리 볼륨이 마운트된 위치를 확인합니다.

findmnt -o SOURCE,TARGET /dev/VolumeGroupName/LogicalVolumeName SOURCE TARGET /dev/mapper/VolumeGroupName-NewLogicalVolumeName /MountPoint

# findmnt -o SOURCE,TARGET /dev/VolumeGroupName/LogicalVolumeName SOURCE TARGET /dev/mapper/VolumeGroupName-NewLogicalVolumeName /MountPointCopy to Clipboard Copied! Toggle word wrap Toggle overflow /dev/VolumeGroupName/LogicalVolumeName 을 논리 볼륨의 경로로 바꿉니다.

논리 볼륨을 마운트 해제합니다.

umount /MountPoint

# umount /MountPointCopy to Clipboard Copied! Toggle word wrap Toggle overflow /MountPoint 를 논리 볼륨의 마운트 지점으로 바꿉니다.

파일 시스템 오류를 확인하고 복구합니다.

e2fsck -f /dev/VolumeGroupName/LogicalVolumeName

# e2fsck -f /dev/VolumeGroupName/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow LV 및 파일 시스템의 크기를 조정합니다.

lvreduce --size TargetSize --resizefs VolumeGroupName/LogicalVolumeName

# lvreduce --size TargetSize --resizefs VolumeGroupName/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow TargetSize 를 LV의 새 크기로 바꿉니다. VolumeGroupName/LogicalVolumeName 을 논리 볼륨의 경로로 바꿉니다.

파일 시스템을 다시 마운트합니다.

mount -o remount /MountPoint

# mount -o remount /MountPointCopy to Clipboard Copied! Toggle word wrap Toggle overflow /MountPoint 를 파일 시스템의 마운트 지점으로 바꿉니다.

검증

파일 시스템의 공간 사용량을 확인합니다.

df -hT /MountPoint/ Filesystem Type Size Used Avail Use% Mounted on /dev/mapper/VolumeGroupName-NewLogicalVolumeName ext4 2.9G 139K 2.7G 1% /MountPoint

# df -hT /MountPoint/ Filesystem Type Size Used Avail Use% Mounted on /dev/mapper/VolumeGroupName-NewLogicalVolumeName ext4 2.9G 139K 2.7G 1% /MountPointCopy to Clipboard Copied! Toggle word wrap Toggle overflow /MountPoint 를 논리 볼륨의 마운트 지점으로 바꿉니다.

LV의 크기를 확인합니다.

lvs -o lv_name,lv_size LV LSize NewLogicalVolumeName 4.00g

# lvs -o lv_name,lv_size LV LSize NewLogicalVolumeName 4.00gCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4. 논리 볼륨 이름 변경

lvrename 명령을 사용하여 스냅샷을 포함한 기존 논리 볼륨의 이름을 변경할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

논리 볼륨 및 해당 볼륨 그룹을 나열합니다.

lvs -o lv_name,vg_name LV VG LogicalVolumeName VolumeGroupName

# lvs -o lv_name,vg_name LV VG LogicalVolumeName VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 논리 볼륨의 이름을 변경합니다.

lvrename VolumeGroupName/LogicalVolumeName VolumeGroupName/NewLogicalVolumeName

# lvrename VolumeGroupName/LogicalVolumeName VolumeGroupName/NewLogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. LogicalVolumeName 을 논리 볼륨의 이름으로 바꿉니다. NewLogicalVolumeName 을 새 논리 볼륨 이름으로 교체합니다.

검증

논리 볼륨의 이름이 변경되었는지 확인합니다.

lvs -o lv_name LV NewLogicalVolumeName

# lvs -o lv_name LV NewLogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5. 논리 볼륨 제거

lvremove 명령을 사용하여 스냅샷을 포함한 기존 논리 볼륨을 제거할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

논리 볼륨 및 해당 경로를 나열합니다.

lvs -o lv_name,lv_path LV Path LogicalVolumeName /dev/VolumeGroupName/LogicalVolumeName

# lvs -o lv_name,lv_path LV Path LogicalVolumeName /dev/VolumeGroupName/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 논리 볼륨이 마운트된 위치를 확인합니다.

findmnt -o SOURCE,TARGET /dev/VolumeGroupName/LogicalVolumeName SOURCE TARGET /dev/mapper/VolumeGroupName-LogicalVolumeName /MountPoint

# findmnt -o SOURCE,TARGET /dev/VolumeGroupName/LogicalVolumeName SOURCE TARGET /dev/mapper/VolumeGroupName-LogicalVolumeName /MountPointCopy to Clipboard Copied! Toggle word wrap Toggle overflow /dev/VolumeGroupName/LogicalVolumeName 을 논리 볼륨의 경로로 바꿉니다.

논리 볼륨을 마운트 해제합니다.

umount /MountPoint

# umount /MountPointCopy to Clipboard Copied! Toggle word wrap Toggle overflow /MountPoint 를 논리 볼륨의 마운트 지점으로 바꿉니다.

논리 볼륨을 제거합니다.

lvremove VolumeGroupName/LogicalVolumeName

# lvremove VolumeGroupName/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName/LogicalVolumeName 을 논리 볼륨의 경로로 바꿉니다.

4.6. 논리 볼륨 활성화

lvchange 명령을 사용하여 논리 볼륨을 활성화할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

논리 볼륨, 해당 볼륨 그룹 및 해당 경로를 나열합니다.

lvs -o lv_name,vg_name,lv_path LV VG Path LogicalVolumeName VolumeGroupName VolumeGroupName/LogicalVolumeName

# lvs -o lv_name,vg_name,lv_path LV VG Path LogicalVolumeName VolumeGroupName VolumeGroupName/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 논리 볼륨을 활성화합니다.

lvchange --activate y VolumeGroupName/LogicalVolumeName

# lvchange --activate y VolumeGroupName/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. LogicalVolumeName 을 논리 볼륨의 이름으로 바꿉니다.

참고다른 LV의 스냅샷으로 생성된 thin LV를 활성화하는 경우

--ignoreactivationskip옵션을 사용하여 활성화해야 할 수 있습니다.

검증

LV가 활성 상태인지 확인합니다.

lvdisplay VolumeGroupName/LogicalVolumeName ... LV Status available

# lvdisplay VolumeGroupName/LogicalVolumeName ... LV Status availableCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. LogicalVolumeName 을 논리 볼륨의 이름으로 바꿉니다.

4.7. 논리 볼륨 비활성화

기본적으로 논리 볼륨을 생성할 때 활성 상태입니다. lvchange 명령을 사용하여 논리 볼륨을 비활성화할 수 있습니다.

활성 마운트 또는 사용으로 논리 볼륨을 비활성화하면 데이터 불일치 및 시스템 오류가 발생할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

논리 볼륨, 해당 볼륨 그룹 및 해당 경로를 나열합니다.

lvs -o lv_name,vg_name,lv_path LV VG Path LogicalVolumeName VolumeGroupName /dev/VolumeGroupName/LogicalVolumeName

# lvs -o lv_name,vg_name,lv_path LV VG Path LogicalVolumeName VolumeGroupName /dev/VolumeGroupName/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 논리 볼륨이 마운트된 위치를 확인합니다.

findmnt -o SOURCE,TARGET /dev/VolumeGroupName/LogicalVolumeName SOURCE TARGET /dev/mapper/VolumeGroupName-LogicalVolumeName /MountPoint

# findmnt -o SOURCE,TARGET /dev/VolumeGroupName/LogicalVolumeName SOURCE TARGET /dev/mapper/VolumeGroupName-LogicalVolumeName /MountPointCopy to Clipboard Copied! Toggle word wrap Toggle overflow /dev/VolumeGroupName/LogicalVolumeName 을 논리 볼륨의 경로로 바꿉니다.

논리 볼륨을 마운트 해제합니다.

umount /MountPoint

# umount /MountPointCopy to Clipboard Copied! Toggle word wrap Toggle overflow /MountPoint 를 논리 볼륨의 마운트 지점으로 바꿉니다.

논리 볼륨을 비활성화합니다.

lvchange --activate n VolumeGroupName/LogicalVolumeName

# lvchange --activate n VolumeGroupName/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. LogicalVolumeName 을 논리 볼륨의 이름으로 바꿉니다.

검증

LV가 활성 상태가 아닌지 확인합니다.

lvdisplay VolumeGroupName/LogicalVolumeName ... LV Status NOT available

# lvdisplay VolumeGroupName/LogicalVolumeName ... LV Status NOT availableCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. LogicalVolumeName 을 논리 볼륨의 이름으로 바꿉니다.

5장. 고급 논리 볼륨 관리

LVM에는 다음과 같은 고급 기능이 포함되어 있습니다.

- 스냅샷: point-in-time copies of logical volumes (LV)

- 캐싱 - 느린 스토리지의 캐시로 더 빠른 스토리지를 사용할 수 있습니다.

- 사용자 정의 씬 풀 생성

- 사용자 지정 VDO LV 생성

5.1. 논리 볼륨 스냅샷 관리

스냅샷은 특정 시점에서 다른 LV의 콘텐츠를 미러링하는 논리 볼륨(LV)입니다.

5.1.1. 논리 볼륨 스냅샷 이해

스냅샷을 생성할 때 다른 LV의 지정 시간 사본 역할을 하는 새 LV를 생성합니다. 처음에는 스냅샷 LV에 실제 데이터가 포함되어 있지 않습니다. 대신 스냅샷 생성 시 원래 LV의 데이터 블록을 참조합니다.

스냅샷의 스토리지 사용량을 정기적으로 모니터링하는 것이 중요합니다. 스냅샷이 할당된 공간의 100%에 도달하면 유효하지 않습니다.

스냅샷을 완전히 채워지기 전에 스냅샷을 확장해야 합니다. 이 작업은 lvextend 명령을 사용하거나 /etc/lvm/lvm.conf 파일을 통해 자동으로 수행할 수 있습니다.

- 두꺼운 LV 스냅샷

- 원래 LV의 데이터가 변경되면 COW(Copy-On-Write) 시스템은 변경되지 않은 원본 데이터를 변경하기 전에 스냅샷에 복사합니다. 이렇게 하면 변경 사항이 발생할 때만 스냅샷이 크기가 증가하여 스냅샷 생성 시 원본 볼륨의 상태를 저장합니다. 두꺼운 스냅샷은 어느 정도의 스토리지 공간을 미리 할당해야 하는 LV의 유형입니다. 이 양은 나중에 확장 또는 축소할 수 있지만 원래 LV에 어떤 유형의 변경 사항을 고려해야 합니다. 이렇게 하면 공간을 너무 많이 할당하거나 너무 적게 할당하면 스냅샷 크기를 자주 늘려야 합니다.

- thin LV 스냅샷

씬 스냅샷은 씬 프로비저닝된 기존 LV에서 생성된 LV의 유형입니다. 씬 스냅샷은 추가 공간을 미리 할당할 필요가 없습니다. 처음에 원래 LV와 해당 스냅샷은 모두 동일한 데이터 블록을 공유합니다. 원래 LV를 변경하면 새 데이터를 다른 블록에 쓰는 반면 스냅샷은 원본 블록을 계속 참조하여 스냅샷 생성 시 LV의 데이터에 대한 지정 시간 보기를 유지합니다.

씬 프로비저닝은 필요에 따라 디스크 공간을 할당하여 스토리지를 효율적으로 최적화하고 관리하는 방법입니다. 즉, 각 LV에 대량의 스토리지를 미리 할당할 필요 없이 여러 LV를 생성할 수 있습니다. 스토리지는 씬 풀의 모든 LV에서 공유되므로 리소스를 보다 효율적으로 사용할 수 있습니다. 씬 풀은 필요에 따라 해당 LV에 공간을 할당합니다.

- 씩과 씬 LV 스냅샷 중에서 선택

- 씩 또는 씬 LV 스냅샷 중 하나를 선택하는 것은 스냅샷을 생성하는 LV 유형에 따라 직접 결정됩니다. 원래 LV가 두꺼운 LV인 경우 스냅샷이 두꺼운 것입니다. 원래 LV가 씬된 경우 스냅샷이 씬됩니다.

5.1.2. 씩의 논리 볼륨 스냅샷 관리

두꺼운 LV 스냅샷을 생성하는 경우 스냅샷의 스토리지 요구 사항과 수명을 고려해야 합니다. 원래 볼륨에 대한 예상 변경 사항에 따라 충분한 스토리지를 할당해야 합니다. 스냅샷에는 의도한 수명 동안 변경 사항을 캡처하기에 충분한 크기가 있어야 하지만 원래 LV의 크기를 초과할 수 없습니다. 낮은 변경 속도를 예상하는 경우 스냅샷 크기가 10%-15%로 충분할 수 있습니다. 변경 속도가 높은 LV의 경우 30% 이상을 할당해야 할 수 있습니다.

스냅샷을 완전히 채워지기 전에 스냅샷을 확장해야 합니다. 스냅샷이 할당된 공간의 100%에 도달하면 유효하지 않습니다. lvs -o lv_name,data_percent,origin 명령을 사용하여 스냅샷 용량을 모니터링할 수 있습니다.

5.1.2.1. 씩의 논리 볼륨 스냅샷 생성

lvcreate 명령을 사용하여 두꺼운 LV 스냅샷을 생성할 수 있습니다.

사전 요구 사항

- 관리 액세스.

- 물리 볼륨이 생성되어 있습니다. 자세한 내용은 LVM 물리 볼륨 생성 을 참조하십시오.

- 볼륨 그룹을 생성했습니다. 자세한 내용은 LVM 볼륨 그룹 생성을 참조하십시오.

- 논리 볼륨을 생성했습니다. 자세한 내용은 논리 볼륨 생성 을 참조하십시오.

절차

스냅샷을 생성할 LV를 확인합니다.

lvs -o vg_name,lv_name,lv_size VG LV LSize VolumeGroupName LogicalVolumeName 10.00g

# lvs -o vg_name,lv_name,lv_size VG LV LSize VolumeGroupName LogicalVolumeName 10.00gCopy to Clipboard Copied! Toggle word wrap Toggle overflow 스냅샷 크기는 LV의 크기를 초과할 수 없습니다.

두꺼운 LV 스냅샷을 생성합니다.

lvcreate --snapshot --size SnapshotSize --name SnapshotName VolumeGroupName/LogicalVolumeName

# lvcreate --snapshot --size SnapshotSize --name SnapshotName VolumeGroupName/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow SnapshotSize 를 스냅샷에 할당할 크기(예: 10G)로 바꿉니다. SnapshotName 을 스냅샷 논리 볼륨에 부여하려는 이름으로 교체합니다. VolumeGroupName 을 원래 논리 볼륨이 포함된 볼륨 그룹의 이름으로 교체합니다. LogicalVolumeName 을 스냅샷을 생성할 논리 볼륨의 이름으로 교체합니다.

검증

스냅샷이 생성되었는지 확인합니다.

lvs -o lv_name,origin LV Origin LogicalVolumeName SnapshotName LogicalVolumeName

# lvs -o lv_name,origin LV Origin LogicalVolumeName SnapshotName LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.1.2.2. 논리 볼륨 스냅샷 수동 확장

스냅샷이 할당된 공간의 100%에 도달하면 유효하지 않습니다. 스냅샷을 완전히 채워지기 전에 스냅샷을 확장해야 합니다. 이 작업은 lvextend 명령을 사용하여 수동으로 수행할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

볼륨 그룹, 논리 볼륨, 스냅샷의 소스 볼륨, 사용 백분율 및 크기를 나열합니다.

lvs -o vg_name,lv_name,origin,data_percent,lv_size VG LV Origin Data% LSize VolumeGroupName LogicalVolumeName 10.00g VolumeGroupName SnapshotName LogicalVolumeName 82.00 5.00g

# lvs -o vg_name,lv_name,origin,data_percent,lv_size VG LV Origin Data% LSize VolumeGroupName LogicalVolumeName 10.00g VolumeGroupName SnapshotName LogicalVolumeName 82.00 5.00gCopy to Clipboard Copied! Toggle word wrap Toggle overflow 씩 프로비저닝된 스냅샷을 확장합니다.

lvextend --size +AdditionalSize VolumeGroupName/SnapshotName

# lvextend --size +AdditionalSize VolumeGroupName/SnapshotNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow additional Size 를 스냅샷에 추가할 공간(예: +1G)으로 바꿉니다. VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. SnapshotName 을 스냅샷 이름으로 교체합니다.

검증

LV가 확장되었는지 확인합니다.

lvs -o vg_name,lv_name,origin,data_percent,lv_size VG LV Origin Data% LSize VolumeGroupName LogicalVolumeName 10.00g VolumeGroupName SnapshotName LogicalVolumeName 68.33 6.00g

# lvs -o vg_name,lv_name,origin,data_percent,lv_size VG LV Origin Data% LSize VolumeGroupName LogicalVolumeName 10.00g VolumeGroupName SnapshotName LogicalVolumeName 68.33 6.00gCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.1.2.3. 씩의 논리 볼륨 스냅샷 자동 확장

스냅샷이 할당된 공간의 100%에 도달하면 유효하지 않습니다. 스냅샷을 완전히 채워지기 전에 스냅샷을 확장해야 합니다. 이 작업은 자동으로 수행할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

-

root사용자로 선택한 편집기에서/etc/lvm/lvm.conf파일을 엽니다. snapshot_autoextend_threshold및snapshot_autoextend_percent행의 주석을 제거하고 각 매개변수를 필수 값으로 설정합니다.snapshot_autoextend_threshold = 70 snapshot_autoextend_percent = 20

snapshot_autoextend_threshold = 70 snapshot_autoextend_percent = 20Copy to Clipboard Copied! Toggle word wrap Toggle overflow snapshot_autoextend_threshold는 LVM이 스냅샷을 자동 연장하기 시작하는 백분율을 결정합니다. 예를 들어 매개 변수를 70으로 설정하면 LVM에서 스냅샷이 70% 용량에 도달할 때 스냅샷을 확장하려고 합니다.snapshot_autoextend_percent는 임계값에 도달하면 스냅샷을 확장해야 하는 백분율로 지정합니다. 예를 들어 매개 변수를 20으로 설정하면 스냅샷이 현재 크기의 20%가 증가합니다.- 변경 사항을 저장하고 편집기를 종료합니다.

lvm2-monitor를 다시 시작하십시오.systemctl restart lvm2-monitor

# systemctl restart lvm2-monitorCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.1.2.4. 씩의 논리 볼륨 스냅샷 병합

두꺼운 LV 스냅샷을 스냅샷이 생성된 원래 논리 볼륨에 병합할 수 있습니다. 병합 프로세스는 원래 LV가 스냅샷이 생성될 때의 상태로 되돌리는 것을 의미합니다. 병합이 완료되면 스냅샷이 제거됩니다.

원본과 스냅샷 LV 간의 병합이 활성 상태이면 지연됩니다. LV가 다시 활성화되고 사용되지 않는 경우에만 실행됩니다.

사전 요구 사항

- 관리 액세스.

절차

LV, 해당 볼륨 그룹 및 해당 경로를 나열합니다.

lvs -o lv_name,vg_name,lv_path LV VG Path LogicalVolumeName VolumeGroupName /dev/VolumeGroupName/LogicalVolumeName SnapshotName VolumeGroupName /dev/VolumeGroupName/SnapshotName

# lvs -o lv_name,vg_name,lv_path LV VG Path LogicalVolumeName VolumeGroupName /dev/VolumeGroupName/LogicalVolumeName SnapshotName VolumeGroupName /dev/VolumeGroupName/SnapshotNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow LV가 마운트된 위치를 확인합니다.

findmnt -o SOURCE,TARGET /dev/VolumeGroupName/LogicalVolumeName findmnt -o SOURCE,TARGET /dev/VolumeGroupName/SnapshotName

# findmnt -o SOURCE,TARGET /dev/VolumeGroupName/LogicalVolumeName # findmnt -o SOURCE,TARGET /dev/VolumeGroupName/SnapshotNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow /dev/VolumeGroupName/LogicalVolumeName 을 논리 볼륨의 경로로 바꿉니다. /dev/VolumeGroupName/SnapshotName 을 스냅샷 경로로 바꿉니다.

LV를 마운트 해제합니다.

umount /LogicalVolume/MountPoint umount /Snapshot/MountPoint

# umount /LogicalVolume/MountPoint # umount /Snapshot/MountPointCopy to Clipboard Copied! Toggle word wrap Toggle overflow /LogicalVolume/MountPoint 를 논리 볼륨의 마운트 지점으로 바꿉니다. /Snapshot/MountPoint 를 스냅샷의 마운트 지점으로 바꿉니다.

LV를 비활성화합니다.

lvchange --activate n VolumeGroupName/LogicalVolumeName lvchange --activate n VolumeGroupName/SnapshotName

# lvchange --activate n VolumeGroupName/LogicalVolumeName # lvchange --activate n VolumeGroupName/SnapshotNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. LogicalVolumeName 을 논리 볼륨의 이름으로 바꿉니다. SnapshotName 을 스냅샷 이름으로 교체합니다.

두꺼운 LV 스냅샷을 원본으로 병합합니다.

lvconvert --merge SnapshotName

# lvconvert --merge SnapshotNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow SnapshotName 을 스냅샷 이름으로 교체합니다.

LV를 활성화합니다.

lvchange --activate y VolumeGroupName/LogicalVolumeName

# lvchange --activate y VolumeGroupName/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. LogicalVolumeName 을 논리 볼륨의 이름으로 바꿉니다.

LV를 마운트합니다.

umount /LogicalVolume/MountPoint

# umount /LogicalVolume/MountPointCopy to Clipboard Copied! Toggle word wrap Toggle overflow /LogicalVolume/MountPoint 를 논리 볼륨의 마운트 지점으로 바꿉니다.

검증

스냅샷이 제거되었는지 확인합니다.

lvs -o lv_name

# lvs -o lv_nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.1.3. thin 논리 볼륨 스냅샷 관리

씬 프로비저닝은 스토리지 효율성이 우선 순위인 경우에 적합합니다. 스토리지 공간 동적 할당은 초기 스토리지 비용을 줄이고 사용 가능한 스토리지 리소스 사용을 극대화합니다. 동적 워크로드가 있거나 스토리지가 시간이 지남에 따라 증가하는 환경에서 씬 프로비저닝을 통해 유연성을 높일 수 있습니다. 스토리지 공간을 크게 사전 할당할 필요 없이 스토리지 시스템을 변화하는 요구에 맞게 조정할 수 있습니다. 동적 할당을 사용하면 모든 LV의 총 크기가 씬 풀의 물리적 크기를 초과할 수 있으므로 모든 공간이 동시에 활용되는 것은 아닙니다.

5.1.3.1. 씬 논리 볼륨 스냅샷 생성

lvcreate 명령을 사용하여 thin LV 스냅샷을 생성할 수 있습니다. thin LV 스냅샷을 생성할 때 스냅샷 크기를 지정하지 마십시오. size 매개변수를 포함하면 대신 두꺼운 스냅샷이 생성됩니다.

사전 요구 사항

- 관리 액세스.

- 물리 볼륨이 생성되어 있습니다. 자세한 내용은 LVM 물리 볼륨 생성 을 참조하십시오.

- 볼륨 그룹을 생성했습니다. 자세한 내용은 LVM 볼륨 그룹 생성을 참조하십시오.

- 논리 볼륨을 생성했습니다. 자세한 내용은 논리 볼륨 생성 을 참조하십시오.

절차

스냅샷을 생성할 LV를 확인합니다.

lvs -o lv_name,vg_name,pool_lv,lv_size LV VG Pool LSize PoolName VolumeGroupName 152.00m ThinVolumeName VolumeGroupName PoolName 100.00m

# lvs -o lv_name,vg_name,pool_lv,lv_size LV VG Pool LSize PoolName VolumeGroupName 152.00m ThinVolumeName VolumeGroupName PoolName 100.00mCopy to Clipboard Copied! Toggle word wrap Toggle overflow thin LV 스냅샷을 생성합니다.

lvcreate --snapshot --name SnapshotName VolumeGroupName/ThinVolumeName

# lvcreate --snapshot --name SnapshotName VolumeGroupName/ThinVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow SnapshotName 을 스냅샷 논리 볼륨에 부여하려는 이름으로 교체합니다. VolumeGroupName 을 원래 논리 볼륨이 포함된 볼륨 그룹의 이름으로 교체합니다. ThinVolumeName 을 스냅샷을 생성할 thin 논리 볼륨의 이름으로 바꿉니다.

검증

스냅샷이 생성되었는지 확인합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.1.3.2. 씬 논리 볼륨 스냅샷 병합

thin LV 스냅샷을 생성된 원래 논리 볼륨에 병합할 수 있습니다. 병합 프로세스는 원래 LV가 스냅샷이 생성될 때의 상태로 되돌리는 것을 의미합니다. 병합이 완료되면 스냅샷이 제거됩니다.

사전 요구 사항

- 관리 액세스.

절차

LV, 해당 볼륨 그룹 및 해당 경로를 나열합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 원래 LV가 마운트된 위치를 확인합니다.

findmnt -o SOURCE,TARGET /dev/VolumeGroupName/ThinVolumeName

# findmnt -o SOURCE,TARGET /dev/VolumeGroupName/ThinVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName/ThinVolumeName 을 논리 볼륨의 경로로 바꿉니다.

LV를 마운트 해제합니다.

umount /ThinLogicalVolume/MountPoint

# umount /ThinLogicalVolume/MountPointCopy to Clipboard Copied! Toggle word wrap Toggle overflow /ThinLogicalVolume/MountPoint 를 논리 볼륨의 마운트 지점으로 바꿉니다. /ThinSnapshot/MountPoint 를 스냅샷의 마운트 지점으로 바꿉니다.

LV를 비활성화합니다.

lvchange --activate n VolumeGroupName/ThinLogicalVolumeName

# lvchange --activate n VolumeGroupName/ThinLogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. ThinLogicalVolumeName 을 논리 볼륨의 이름으로 바꿉니다.

thin LV 스냅샷을 원본과 병합합니다.

lvconvert --mergethin VolumeGroupName/ThinSnapshotName

# lvconvert --mergethin VolumeGroupName/ThinSnapshotNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. ThinSnapshotName 을 스냅샷 이름으로 교체합니다.

LV를 마운트합니다.

umount /ThinLogicalVolume/MountPoint

# umount /ThinLogicalVolume/MountPointCopy to Clipboard Copied! Toggle word wrap Toggle overflow /ThinLogicalVolume/MountPoint 를 논리 볼륨의 마운트 지점으로 바꿉니다.

검증

원래 LV가 병합되었는지 확인합니다.

lvs -o lv_name

# lvs -o lv_nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2. 논리 볼륨 캐싱

dm-cache 또는 dm-writecache 대상을 사용하여 논리 볼륨을 캐시할 수 있습니다.

DM-cache 는 속도가 느린 스토리지 장치(HDD)의 캐시로 더 빠른 SSD(스토리지 장치)를 사용합니다. 읽기 및 쓰기 데이터를 캐시하여 자주 사용하는 데이터에 대한 액세스 시간을 최적화합니다. 읽기 및 쓰기 작업을 강화하면 성능이 크게 향상될 수 있는 혼합 워크로드 환경에서 유용합니다.

DM-writecache 는 기본 스토리지 장치(HDD)에 커밋되기 전에 더 빠른 SSD(스토리지 미디어)를 사용하여 쓰기 데이터를 임시로 보관하여 쓰기 작업을 최적화합니다. 쓰기 성능이 데이터 전송 프로세스의 속도가 느려질 수 있는 쓰기 집약적인 애플리케이션에 유용합니다.

5.2.1. dm-cache를 사용하여 논리 볼륨 캐싱

dm-cache 를 사용하여 LV를 캐시하면 캐시 풀이 생성됩니다. 캐시 풀은 실제 캐시된 콘텐츠를 저장하는 캐시 데이터와 캐시에 저장된 콘텐츠를 추적하는 캐시 메타데이터를 결합하는 LV입니다. 그런 다음 이 풀은 특정 LV와 연결하여 해당 데이터를 캐시합니다.

DM -cache 는 두 가지 유형의 블록을 대상으로 합니다. 자주 액세스하는(hot) 블록은 캐시로 이동하고 덜 자주 액세스(cold) 블록은 느린 장치에 남아 있습니다.

사전 요구 사항

- 관리 액세스.

절차

캐시할 LV 및 해당 볼륨 그룹을 표시합니다.

lvs -o lv_name,vg_name LV VG LogicalVolumeName VolumeGroupName

# lvs -o lv_name,vg_name LV VG LogicalVolumeName VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 캐시 풀을 생성합니다.

lvcreate --type cache-pool --name CachePoolName --size Size VolumeGroupName /FastDevicePath

# lvcreate --type cache-pool --name CachePoolName --size Size VolumeGroupName /FastDevicePathCopy to Clipboard Copied! Toggle word wrap Toggle overflow CachePoolName 을 캐시 풀 이름으로 교체합니다. Size 를 캐시 풀의 크기로 바꿉니다. VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. /FastDevicePath 를 빠른 장치의 경로(예: SSD 또는 NVME)로 바꿉니다.

캐시 풀을 LV에 연결합니다.

lvconvert --type cache --cachepool VolumeGroupName/CachePoolName VolumeGroupName/LogicalVolumeName

# lvconvert --type cache --cachepool VolumeGroupName/CachePoolName VolumeGroupName/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

LV가 캐시되었는지 확인합니다.

lvs -o lv_name,pool_lv LV Pool LogicalVolumeName [CachePoolName_cpool]

# lvs -o lv_name,pool_lv LV Pool LogicalVolumeName [CachePoolName_cpool]Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2.2. dm-writecache를 사용하여 논리 볼륨 캐싱

dm-writecache 를 사용하여 LV를 캐시할 때 논리 볼륨과 물리 스토리지 장치 간의 캐싱 계층이 생성됩니다. dm-writecache 는 결국 SSD와 같은 빠른 스토리지 매체에 쓰기 작업을 임시로 저장하여 기본 스토리지 장치에 다시 쓰기 작업을 작성하여 쓰기 집약적인 워크로드를 최적화함으로써 작동합니다.

사전 요구 사항

- 관리 액세스.

절차

캐시할 논리 볼륨 및 해당 볼륨 그룹을 표시합니다.

lvs -o lv_name,vg_name LV VG LogicalVolumeName VolumeGroupName

# lvs -o lv_name,vg_name LV VG LogicalVolumeName VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 캐시 볼륨을 생성합니다.

lvcreate --name CacheVolumeName --size Size VolumeGroupName /FastDevicePath

# lvcreate --name CacheVolumeName --size Size VolumeGroupName /FastDevicePathCopy to Clipboard Copied! Toggle word wrap Toggle overflow CacheVolumeName 을 캐시 볼륨의 이름으로 교체합니다. Size 를 캐시 풀의 크기로 바꿉니다. VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. /FastDevicePath 를 빠른 장치의 경로(예: SSD 또는 NVME)로 바꿉니다.

캐시 볼륨을 LV에 연결합니다.

lvconvert --type writecache --cachevol CacheVolumeName VolumeGroupName/LogicalVolumeName

# lvconvert --type writecache --cachevol CacheVolumeName VolumeGroupName/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow CacheVolumeName 을 캐시 볼륨의 이름으로 교체합니다. VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. LogicalVolumeName 을 논리 볼륨의 이름으로 바꿉니다.

검증

LV가 캐시되었는지 확인합니다.

lvs -o lv_name,pool_lv LV Pool LogicalVolumeName [CacheVolumeName_cvol]

# lvs -o lv_name,pool_lv LV Pool LogicalVolumeName [CacheVolumeName_cvol]Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2.3. 논리 볼륨 분리

두 가지 주요 방법을 사용하여 LV에서 캐싱을 제거합니다.

- 분할

- LV에서 캐시를 분리할 수 있지만 캐시 볼륨 자체를 유지할 수 있습니다. 이 경우 LV는 더 이상 캐싱 메커니즘의 이점을 받지 않지만 캐시 볼륨과 데이터는 그대로 유지됩니다. 캐시 볼륨은 보존되지만 캐시 내의 데이터를 재사용할 수 없으며 다음에 캐싱 설정에 사용될 때 삭제됩니다.

- Uncaching

- LV에서 캐시를 분리하고 캐시 볼륨을 완전히 제거할 수 있습니다. 이 작업은 캐시를 효과적으로 제거하여 공간을 확보합니다.

사전 요구 사항

- 관리 액세스.

절차

캐시된 LV를 표시합니다.

lvs -o lv_name,pool_lv,vg_name LV Pool VG LogicalVolumeName [CacheVolumeName_cvol] VolumeGroupName

# lvs -o lv_name,pool_lv,vg_name LV Pool VG LogicalVolumeName [CacheVolumeName_cvol] VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 캐시된 볼륨을 분리하거나 제거합니다.

캐시된 볼륨을 분리하려면 다음을 사용합니다.

lvconvert --splitcache VolumeGroupName/LogicalVolumeName

# lvconvert --splitcache VolumeGroupName/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 캐시된 볼륨을 분리 및 제거하려면 다음을 사용합니다.

lvconvert --uncache VolumeGroupName/LogicalVolumeName

# lvconvert --uncache VolumeGroupName/LogicalVolumeNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다. LogicalVolumeName 을 논리 볼륨의 이름으로 바꿉니다.

검증

LV가 캐시되지 않았는지 확인합니다.

lvs -o lv_name,pool_lv

# lvs -o lv_name,pool_lvCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3. 사용자 지정 씬 풀 생성

사용자 지정 씬 풀을 생성하여 스토리지를 보다 효과적으로 제어할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

사용 가능한 볼륨 그룹을 표시합니다.

vgs -o vg_name VG VolumeGroupName

# vgs -o vg_name VG VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 사용 가능한 장치를 나열합니다.

lsblk

# lsblkCopy to Clipboard Copied! Toggle word wrap Toggle overflow thin 풀 데이터를 저장할 LV를 만듭니다.

lvcreate --name ThinPoolDataName --size Size VolumeGroupName /DevicePath

# lvcreate --name ThinPoolDataName --size Size VolumeGroupName /DevicePathCopy to Clipboard Copied! Toggle word wrap Toggle overflow ThinPoolDataName 을 씬 풀 data LV의 이름으로 바꿉니다. Size 를 LV의 크기로 바꿉니다. VolumeGroupName 을 볼륨 그룹의 이름으로 교체합니다.

thin pool 메타데이터를 보유하도록 LV를 생성합니다.

lvcreate --name ThinPoolMetadataName --size Size VolumeGroupName /DevicePath

# lvcreate --name ThinPoolMetadataName --size Size VolumeGroupName /DevicePathCopy to Clipboard Copied! Toggle word wrap Toggle overflow LV를 씬 풀로 결합합니다.

lvconvert --type thin-pool --poolmetadata ThinPoolMetadataName VolumeGroupName/ThinPoolDataName

# lvconvert --type thin-pool --poolmetadata ThinPoolMetadataName VolumeGroupName/ThinPoolDataNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

사용자 지정 thin 풀이 생성되었는지 확인합니다.

lvs -o lv_name,seg_type LV Type ThinPoolDataName thin-pool

# lvs -o lv_name,seg_type LV Type ThinPoolDataName thin-poolCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4. 사용자 지정 VDO 논리 볼륨 생성

LVM(Logical Volume Manager)을 사용하면 데이터 저장을 위해 VDO(Virtual Data Optimizer) 풀을 사용하는 사용자 지정 LV를 생성할 수 있습니다.

사전 요구 사항

- 관리 액세스.

절차

VG를 표시합니다.

vgs VG #PV #LV #SN Attr VSize VFree VolumeGroupName 1 0 0 wz--n- 28.87g 28.87g

# vgs VG #PV #LV #SN Attr VSize VFree VolumeGroupName 1 0 0 wz--n- 28.87g 28.87gCopy to Clipboard Copied! Toggle word wrap Toggle overflow VDO 풀로 변환할 LV를 만듭니다.

lvcreate --name VDOPoolName --size Size VolumeGroupName

# lvcreate --name VDOPoolName --size Size VolumeGroupNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VDOPoolName 을 VDO 풀의 이름으로 바꿉니다. Size 를 VDO 풀의 크기로 바꿉니다. VolumeGroupName 을 VG의 이름으로 바꿉니다.

이 LV를 VDO 풀로 변환합니다. 이 변환에서는 VDO 풀을 사용하는 새 VDO LV를 생성합니다.

lvcreate은 새 VDO LV를 생성하므로 새 VDO LV에 대한 매개변수를 지정해야 합니다.--name|-n을 사용하여 새 VDO LV의 이름을 지정하고--virtualsize|-V를 사용하여 새 VDO LV의 크기를 지정합니다.lvconvert --type vdo-pool --name VDOVolumeName --virtualsize VDOVolumeSize VolumeGroupName/VDOPoolName

# lvconvert --type vdo-pool --name VDOVolumeName --virtualsize VDOVolumeSize VolumeGroupName/VDOPoolNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow VDOVolumeName 을 VDO 볼륨의 이름으로 바꿉니다. VDOVolumeSize 를 VDO 볼륨의 크기로 바꿉니다. VolumeGroupName/VDOPoolName 을 VG 및 VDO 풀의 이름으로 교체합니다.

검증

LV가 VDO 풀로 변환되었는지 확인합니다.

*# lvs -o lv_name,vg_name,seg_type* LV VG Type VDOPoolName VolumeGroupName vdo-pool VDOVolumeName VolumeGroupName vdo

*# lvs -o lv_name,vg_name,seg_type* LV VG Type VDOPoolName VolumeGroupName vdo-pool VDOVolumeName VolumeGroupName vdoCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6장. 스냅샷을 사용하여 시스템 업그레이드 관리

Red Hat Enterprise Linux 시스템의 롤백 기능을 수행하여 이전 버전의 운영 체제로 돌아갑니다. Boom Boot Manager 및 Leapp 운영 체제 현대화 프레임워크를 사용할 수 있습니다.

운영 체제 업그레이드를 수행하기 전에 다음 측면을 고려하십시오.

-

스냅샷이 있는 시스템 업그레이드는 시스템 트리의 여러 파일 시스템(예: 별도의

/var또는/usr파티션)에서 작동하지 않습니다. - 스냅샷이 있는 시스템 업그레이드는 RHUI(Red Hat Update Infrastructure) 시스템에서 작동하지 않습니다. Boom 유틸리티를 사용하는 대신 VM(가상 머신)의 스냅샷을 생성하는 것이 좋습니다.

6.1. Boom 프로세스 개요

Boom Boot Manager를 사용하여 부팅 항목을 생성하여 GRUB 부트 로더 메뉴에서 이러한 항목을 선택하고 액세스할 수 있습니다. 부팅 항목을 생성하면 업그레이드 가능한 롤백 준비 프로세스가 간소화됩니다.

다음 부팅 항목은 업그레이드 및 롤백 프로세스의 일부입니다.

부팅 항목 업그레이드Leapp 업그레이드 환경을 부팅합니다.

leapp유틸리티를 사용하여 이 부팅 항목을 만들고 관리합니다.leapp업그레이드 프로세스에서 이 항목을 자동으로 제거합니다.Red Hat Enterprise Linux 9 부팅 항목업그레이드 시스템 환경을 부팅합니다. 업그레이드 프로세스가 성공한 후

leapp유틸리티를 사용하여 이 부팅 항목을 생성합니다.스냅샷 부팅 항목원래 시스템의 스냅샷을 부팅합니다. 업그레이드 시도에 성공하거나 실패한 후 이전 운영 체제 상태를 검토하고 테스트합니다. 운영 체제를 업그레이드하기 전에

boom명령을 사용하여 이 부팅 항목을 생성합니다.부팅 항목 롤백원래 시스템 환경을 부팅하고 이전 시스템 상태로의 업그레이드를 롤백합니다. 업그레이드 절차의 롤백을 시작할 때

boom명령을 사용하여 이 부팅 항목을 생성합니다.

6.2. Boom Boot Manager를 사용하여 다른 버전으로 업그레이드

Boom Boot Manager를 사용하여 Red Hat Enterprise Linux 운영 체제 업그레이드를 수행합니다.

사전 요구 사항

- Red Hat Enterprise Linux 8.8 또는 8.10을 실행하고 있습니다.

-

현재

boom-boot패키지 (버전 boom-boot-1.3-2.el8 이상)를 설치했습니다. - 스냅샷에 사용할 수 있는 충분한 공간이 있습니다. 원래 설치 크기에 따라 크기를 추정합니다. 마운트된 논리 볼륨을 모두 나열합니다.

-

leapp패키지를 설치했습니다. - 소프트웨어 리포지토리를 활성화했습니다.

추가 파일 시스템에는 /usr 또는 /var 이 포함될 수 있습니다.

절차

루트 논리 볼륨의 스냅샷을 생성합니다.

루트 파일 시스템에서 thin provisioning을 사용하는 경우 thin 스냅샷을 생성합니다.

lvcreate -s rhel/root -kn -n root_snapshot_before_changes Logical volume "root_snapshot_before_changes" created.

# lvcreate -s rhel/root -kn -n root_snapshot_before_changes Logical volume "root_snapshot_before_changes" created.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 여기:

-

-s는 스냅샷을 생성합니다. -

RHEL/root는 파일 시스템을 논리 볼륨에 복사합니다. -

-KN은 부팅 시 LV를 자동으로 활성화합니다. -n root_snapshot_before_changes에는 스냅샷 이름이 표시됩니다.씬 스냅샷을 생성하는 동안 스냅샷 크기를 정의하지 마십시오. 스냅샷은 thin 풀에서 할당됩니다.

-

루트 파일 시스템에서 두꺼운 프로비저닝을 사용하는 경우 두 가지 스냅샷을 생성합니다.

lvcreate -s rhel/root -n root_snapshot_before_changes -L 25g Rounding up size to full physical extent 25 GiB Logical volume "root_snapshot_before_changes" created.

# lvcreate -s rhel/root -n root_snapshot_before_changes -L 25g Rounding up size to full physical extent 25 GiB Logical volume "root_snapshot_before_changes" created.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령에서는 다음을 수행합니다.

-

-s는 스냅샷을 생성합니다. -

RHEL/root는 파일 시스템을 논리 볼륨에 복사합니다. -

-n root_snapshot_before_changes에는 스냅샷 이름이 표시됩니다. -L 25g는 스냅샷 크기입니다. 원래 설치 크기에 따라 크기를 추정합니다.두꺼운 스냅샷을 생성하는 동안 업그레이드 중에 모든 변경 사항을 저장할 수 있는 스냅샷 크기를 정의합니다.

중요생성된 스냅샷에는 추가 시스템 변경 사항이 포함되지 않습니다.

-

프로필을 생성합니다.

프로필을 생성하려면

kexec-tools또는kdumpctl과boom간의 상호 작용을 방지하기 위한 아키텍처별 해결 방법이 필요합니다. 업그레이드 중에 업데이트된kexec-tools패키지는 업데이트된crashkernel설정으로 모든 부팅 항목을 수정하려고 합니다. 이렇게 하면 항목에서 사용하는 부팅 이미지가 삭제됩니다. RHEL 9crashkernel설정을 RHEL 8 프로필 옵션에 추가하여 이 문제를 방지할 수 있습니다.Intel 64 또는 AMD64(x86_64) 또는 IBM Z(s390x) 아키텍처에서 다음을 수행합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 64비트 ARM(AArch64) 아키텍처에서 다음을 수행합니다.

boom profile create --from-host --os-options "root=%{root_device} ro %{root_opts} rhgb quiet crashkernel=1G-4G:256M,4G-64G:320M,64G-:576M"# boom profile create --from-host --os-options "root=%{root_device} ro %{root_opts} rhgb quiet crashkernel=1G-4G:256M,4G-64G:320M,64G-:576M"Copy to Clipboard Copied! Toggle word wrap Toggle overflow IBM POWER little-endian(ppc64le) 아키텍처에서 다음을 수행합니다.

boom profile create --from-host --os-options "root=%{root_device} ro %{root_opts} rhgb quiet crashkernel=2G-4G:384M,4G-16G:512M,16G-64G:1G,64G-128G:2G,128G-:4G" --optional-keys "grub_users grub_arg grub_class id"# boom profile create --from-host --os-options "root=%{root_device} ro %{root_opts} rhgb quiet crashkernel=2G-4G:384M,4G-16G:512M,16G-64G:1G,64G-128G:2G,128G-:4G" --optional-keys "grub_users grub_arg grub_class id"Copy to Clipboard Copied! Toggle word wrap Toggle overflow grub2-mkconfig명령이 10.2.3 단계에서 올바른 부팅 항목을 생성하도록 ppc64le에--optional-keys인수가 필요합니다. 자세한 내용은 RHEL-36180 을 참조하십시오.

원래 부팅 이미지의 백업 사본을 사용하여 원래 시스템의 스냅샷 부팅 항목을 생성합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 여기:

-

--title "Root LV snapshot before changes"는 시스템을 시작하는 동안 부팅 항목 목록에 표시되는 부팅 항목의 이름입니다. --rootlv는 새 부팅 항목에 해당하는 루트 논리 볼륨입니다.이전 단계를 완료한 후 업그레이드하기 전에 원래 시스템에 액세스할 수 있는 부팅 항목이 있습니다.

"WARNING - Boom grub2 통합은 '/boot/../etc/default/boom'에서 비활성화되어 있습니다. 자세한 내용은 RHEL-35983 을 참조하십시오.

ppc64le 아키텍처가 있는 시스템에서 부팅 항목을 업데이트합니다.

grub2-mkconfig -o /boot/grub2/grub.cfg Generating grub configuration file ... Generating boot entries from BLS files... done

# grub2-mkconfig -o /boot/grub2/grub.cfg Generating grub configuration file ... Generating boot entries from BLS files... doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

Leapp 유틸리티를 사용하여 Red Hat Enterprise Linux 9로 업그레이드:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow leapp upgrade명령 보고서에 표시된 모든 차단자를 검토하고 해결합니다. 보고서에 대한 자세한 내용은 업그레이드 전 보고서 검토를 참조하십시오.업그레이드 부팅 항목으로 재부팅합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow GRUB 부팅 화면에서 Red Hat Enterprise Linux Upgrade Initramfs 항목을 선택합니다.

참고Red Hat Enterprise Linux 9에서는 GRUB 부팅 화면의 Snapshots 하위 메뉴를 사용할 수 없습니다.

검증

- 업그레이드가 완료되면 시스템이 자동으로 재부팅됩니다. GRUB 화면에 업그레이드된 (Red Hat Enterprise Linux 9) 및 사용 가능한 운영 체제의 이전 버전이 표시되어 있습니다. 업그레이드된 시스템 버전은 기본 선택 사항입니다.

6.3. Red Hat Enterprise Linux 버전 간 전환

시스템에서 현재 및 이전 Red Hat Enterprise Linux 버전에 동시에 액세스할 수 있습니다. Boom Boot Manager 를 사용하여 다양한 운영 체제 버전에 액세스하면 운영 체제 업그레이드와 관련된 위험이 줄어들고 하드웨어 다운 타임도 줄일 수 있습니다. 환경 간 전환 기능을 사용하면 다음을 수행할 수 있습니다.

- 두 환경을 동시에 신속하게 비교합니다.

- 업그레이드 결과를 평가하는 동안 환경 간에 전환합니다.

- 파일 시스템의 이전 콘텐츠를 복구합니다.

- 업그레이드된 호스트가 실행되는 동안 이전 시스템에 계속 액세스합니다.

- 업데이트 자체가 실행되는 경우에도 언제든지 업데이트 프로세스를 중지하고 되돌립니다.

절차

시스템을 재부팅합니다.

reboot

# rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow - GRUB 부트 로더 화면에서 필요한 부팅 항목을 선택합니다.

검증

선택한 부팅 볼륨이 표시되는지 확인합니다.

cat /proc/cmdline BOOT_IMAGE=(hd0,msdos1)/vmlinuz-4.18.0-513.24.1.el8_9.x86_64.boom0 root=/dev/rhel/root_snapshot_before_changes ro rd.lvm.lv=rhel/root_snapshot_before_changes rhgb quiet crashkernel=1G-4G:192M,4G-64G:256M,64G-:512M

# cat /proc/cmdline BOOT_IMAGE=(hd0,msdos1)/vmlinuz-4.18.0-513.24.1.el8_9.x86_64.boom0 root=/dev/rhel/root_snapshot_before_changes ro rd.lvm.lv=rhel/root_snapshot_before_changes rhgb quiet crashkernel=1G-4G:192M,4G-64G:256M,64G-:512MCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4. 업그레이드에 성공한 후 논리 볼륨 스냅샷 삭제

Boom Boot Manager를 사용하여 시스템을 성공적으로 업그레이드한 경우 스냅샷 부팅 항목과 LV(Logical volume) 스냅샷을 제거하여 업그레이드된 시스템을 사용할 수 있습니다.

LV 스냅샷을 삭제한 후에는 추가 작업을 수행할 수 없습니다.

사전 요구 사항

- 최근에 Boom Boot Manager를 사용하여 Red Hat Enterprise Linux를 최신 버전으로 업그레이드했습니다.