OpenShift에서 AMQ Streams 구성

OpenShift Container Platform에서 AMQ Streams 2.4 배포를 구성하고 관리합니다.

초록

보다 포괄적 수용을 위한 오픈 소스 용어 교체

Red Hat은 코드, 문서, 웹 속성에서 문제가 있는 용어를 교체하기 위해 최선을 다하고 있습니다. 먼저 마스터(master), 슬레이브(slave), 블랙리스트(blacklist), 화이트리스트(whitelist) 등 네 가지 용어를 교체하고 있습니다. 이러한 변경 작업은 작업 범위가 크므로 향후 여러 릴리스에 걸쳐 점차 구현할 예정입니다. 자세한 내용은 CTO Chris Wright의 메시지를 참조하십시오.

1장. 구성 개요

AMQ Streams는 OpenShift 클러스터에서 Apache Kafka 를 실행하는 프로세스를 간소화합니다.

이 가이드에서는 AMQ Streams 배포를 구성하고 관리하는 방법을 설명합니다.

1.1. 사용자 정의 리소스 구성

사용자 정의 리소스를 사용하여 AMQ Streams 배포를 구성합니다.

사용자 정의 리소스를 사용하여 다음 구성 요소의 인스턴스를 구성하고 생성할 수 있습니다.

- Kafka 클러스터

- Kafka Connect 클러스터

- Kafka MirrorMaker

- Kafka 브리지

- 크루즈 컨트롤

사용자 정의 리소스 구성을 사용하여 인스턴스를 관리하거나 배포를 수정하여 추가 기능을 도입할 수도 있습니다. 여기에는 다음을 지원하는 구성이 포함될 수 있습니다.

- Kafka 브로커에 대한 클라이언트 액세스 보안

- 클러스터 외부에서 Kafka 브로커 액세스

- 주제 생성

- 사용자 생성(클라이언트)

- 기능 게이트 제어

- 로깅 빈도 변경

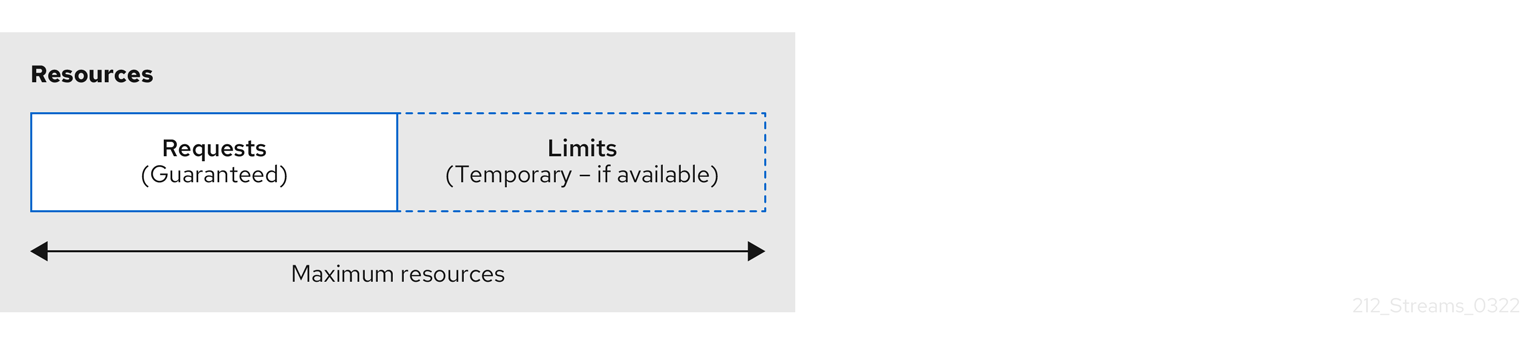

- 리소스 제한 및 요청 할당

- AMQ Streams Drain cleaner, Cruise Control 또는 distributed tracing과 같은 기능 소개

사용자 정의 리소스 API 참조 는 구성에 사용할 수 있는 속성을 설명합니다.

1.2. ConfigMap을 사용하여 구성 추가

ConfigMap 리소스를 사용하여 AMQ Streams 배포에 특정 구성을 추가합니다. ConfigMap은 키-값 쌍을 사용하여 기밀이 아닌 데이터를 저장합니다. ConfigMaps에 추가된 구성 데이터는 한 곳에서 유지 관리되며 구성 요소 간에 재사용할 수 있습니다.

ConfigMap은 다음과 관련된 구성 데이터만 저장할 수 있습니다.

- 로깅 구성

- 메트릭 구성

- Kafka Connect 커넥터의 외부 구성

다른 구성 영역에는 ConfigMap을 사용할 수 없습니다.

구성 요소를 구성할 때 configMapKeyRef 속성을 사용하여 ConfigMap에 대한 참조를 추가할 수 있습니다.

예를 들어 configMapKeyRef 를 사용하여 로깅에 대한 구성을 제공하는 ConfigMap을 참조할 수 있습니다. ConfigMap을 사용하여 Log4j 구성 파일을 전달할 수 있습니다. 로깅 구성에 대한 참조를 추가합니다.

로깅을 위한 ConfigMap 예

메트릭 구성에 ConfigMap을 사용하려면 구성 요소의 metricsConfig 구성에 대한 참조를 동일한 방식으로 추가합니다.

ExternalConfiguration 속성은 pod에 마운트된 ConfigMap(또는 Secret)의 데이터를 환경 변수 또는 볼륨으로 사용할 수 있도록 합니다. Kafka Connect에서 사용하는 커넥터에 대한 외부 구성 데이터를 사용할 수 있습니다. 데이터는 외부 데이터 소스와 관련이 있어 커넥터가 해당 데이터 소스와 통신하는 데 필요한 값을 제공할 수 있습니다.

예를 들어 configMapKeyRef 속성을 사용하여 ConfigMap의 구성 데이터를 환경 변수로 전달할 수 있습니다.

환경 변수 값을 제공하는 ConfigMap의 예

외부에서 관리되는 ConfigMap을 사용하는 경우 구성 공급자를 사용하여 ConfigMaps에서 데이터를 로드합니다. 구성 공급자 사용에 대한 자세한 내용은 3장. 외부 소스에서 구성 값 로드 을 참조하십시오.

1.2.1. 사용자 정의 ConfigMap 이름 지정

AMQ Streams 는 OpenShift에 배포할 때 자체 ConfigMap 및 기타 리소스를 생성합니다. ConfigMaps에는 구성 요소를 실행하는 데 필요한 데이터가 포함되어 있습니다. AMQ Streams에서 생성한 ConfigMap은 편집할 수 없습니다.

생성하는 모든 사용자 정의 ConfigMap에 이러한 기본 ConfigMap과 동일한 이름이 없는지 확인합니다. 동일한 이름이 있는 경우 덮어씁니다. 예를 들어 ConfigMap의 이름이 Kafka 클러스터의 ConfigMap과 동일한 경우 Kafka 클러스터에 대한 업데이트가 있는 경우 덮어씁니다.

1.3. 문서 관련

사용자 대체 값

대체 가능 값이라고도 하는 사용자 대체 값은 이진수에 빙각 대괄호(< >)로 표시됩니다. 밑줄( _ )은 여러 단어 값에 사용됩니다. 값이 코드 또는 명령을 참조하는 경우 monospace 도 사용됩니다.

예를 들어 다음 코드에서 < my_namespace>를 네임스페이스 이름으로 교체하려고 합니다.

sed -i 's/namespace: .*/namespace: <my_namespace>/' install/cluster-operator/*RoleBinding*.yaml

sed -i 's/namespace: .*/namespace: <my_namespace>/' install/cluster-operator/*RoleBinding*.yaml2장. OpenShift 배포에서 AMQ Streams 구성

사용자 정의 리소스를 사용하여 AMQ Streams 배포를 구성합니다. AMQ Streams는 배포를 위해 자체 Kafka 구성 요소 구성을 빌드할 때 시작점으로 사용될 수 있는 설정 파일 예제 를 제공합니다.

사용자 정의 리소스에 적용되는 레이블은 클러스터를 구성하는 OpenShift 리소스에도 적용됩니다. 이를 통해 필요에 따라 리소스의 레이블을 지정할 수 있는 편리한 메커니즘이 제공됩니다.

AMQ Streams 배포 모니터링

Prometheus 및 Grafana를 사용하여 AMQ Streams 배포를 모니터링할 수 있습니다. 자세한 내용은 Kafka에 메트릭 소개를 참조하십시오.

2.1. 표준 Kafka 구성 속성 사용

표준 Kafka 구성 속성을 사용하여 Kafka 구성 요소를 구성합니다.

속성은 다음 Kafka 구성 요소의 구성을 제어하고 조정하는 옵션을 제공합니다.

- 브로커

- 주제

- 클라이언트(생산자 및 소비자)

- 관리자 클라이언트

- Kafka Connect

- Kafka Streams

broker 및 client 매개 변수에는 권한 부여, 인증 및 암호화를 구성하는 옵션이 포함되어 있습니다.

OpenShift의 AMQ Streams의 경우 일부 구성 속성은 AMQ Streams에 의해 완전히 관리되며 변경할 수 없습니다.

Kafka 구성 속성 및 속성을 사용하여 배포를 조정하는 방법에 대한 자세한 내용은 다음 가이드를 참조하십시오.

2.2. Kafka 클러스터 구성

Kafka 리소스를 사용하여 Kafka 배포를 구성합니다. Kafka 클러스터는 ZooKeeper 클러스터와 함께 배포되므로 Kafka 리소스 내의 ZooKeeper에서도 구성 옵션을 사용할 수 있습니다. Entity Operator는 Topic Operator 및 User Operator로 구성됩니다. 배포에 Topic Operator 및 User Operator를 포함하도록 Kafka 리소스에서 entityOperator 속성을 구성할 수도 있습니다.

6.2.1절. “Kafka 스키마 참조” Kafka 리소스의 전체 스키마를 설명합니다.

Apache Kafka에 대한 자세한 내용은 Apache Kafka 설명서 를 참조하십시오.

리스너 구성

클라이언트를 Kafka 브로커에 연결하기 위해 리스너를 구성합니다. 리스너 구성에 대한 자세한 내용은 6.2.4절. “GenericKafkaListener 스키마 참조” 을 참조하십시오.

TLS 인증서 관리

Kafka를 배포할 때 Cluster Operator는 TLS 인증서를 자동으로 설정하고 업데이트하여 클러스터 내에서 암호화 및 인증을 활성화합니다. 필요한 경우 갱신 기간이 시작되기 전에 클러스터 및 클라이언트 CA 인증서를 수동으로 갱신할 수 있습니다. 클러스터 및 클라이언트 CA 인증서에서 사용하는 키를 교체할 수도 있습니다. 자세한 내용은 CA 인증서 갱신 및 개인 키 교체 를 참조하십시오.

2.2.1. Kafka 구성

Kafka 리소스의 속성을 사용하여 Kafka 배포를 구성합니다.

Kafka를 구성할 뿐만 아니라 ZooKeeper 및 AMQ Streams Operator에 대한 구성을 추가할 수 있습니다. 로깅 및 상태 점검과 같은 일반적인 구성 속성은 각 구성 요소에 대해 개별적으로 구성됩니다.

다음 절차에서는 가능한 구성 옵션 중 일부만 보여주지만 특히 중요한 옵션은 다음과 같습니다.

- 리소스 요청 (CPU / 메모리)

- 최대 및 최소 메모리 할당을 위한 JVM 옵션

- 리스너(및 클라이언트 인증)

- 인증

- 스토리지

- Rack 인식

- 메트릭

- cruise Control for cluster rebalancing

Kafka 버전

Kafka 구성에 대한 inter.broker.protocol.version 속성은 지정된 Kafka 버전 (spec.kafka.version)에서 지원하는 버전이어야합니다. 속성은 Kafka 클러스터에서 사용되는 Kafka 프로토콜 버전을 나타냅니다.

Kafka 3.0.0에서 inter.broker.protocol.version 이 3.0 이상으로 설정되면 log.message.format.version 옵션이 무시되고 설정할 필요가 없습니다.

Kafka 버전을 업그레이드할 때 inter.broker.protocol.version 에 대한 업데이트가 필요합니다. 자세한 내용은 Kafka 업그레이드 에서 참조하십시오.

사전 요구 사항

- OpenShift 클러스터

- 실행 중인 Cluster Operator

배포 방법에 대한 자세한 내용은 OpenShift에 AMQ Streams 배포 및 업그레이드 가이드를 참조하십시오.

절차

Kafka리소스의spec속성을 편집합니다.구성할 수 있는 속성은 다음 예제 구성에 표시되어 있습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 2

- 업그레이드 절차에 따라 지원되는 버전으로 변경할 수 있는 Kafka 버전.

- 3

- Kafka 로거 및 로그 수준은 ConfigMap을 통해 직접 (

인라인) 추가되거나 간접적으로 (외부)합니다. 사용자 지정 ConfigMap을log4j.properties키에 배치해야 합니다. Kafkakafka.root.logger.level로거의 경우 로그 수준을 INFO, ERROR, WARN, TRACE, DEBUG, FATAL 또는 OFF로 설정할 수 있습니다. - 4

- 5

- 컨테이너(liveness)를 다시 시작할 시기와 컨테이너가 트래픽을 수락할 수 있는 시기(가용성)를 확인할 수 있는 상태 점검 입니다.

- 6

- 7

- ADVANCED OPTION : 컨테이너 이미지 구성.이는 특별한 경우에만 권장됩니다.

- 8

- 리스너는 클라이언트가 부트스트랩 주소를 통해 Kafka 클러스터에 연결하는 방법을 구성합니다. 리스너는 OpenShift 클러스터 내부 또는 외부에서 연결하기 위해 내부 또는 외부 리스너로 구성됩니다.

- 9

- 리스너를 식별할 이름입니다. Kafka 클러스터 내에서 고유해야 합니다.

- 10

- Kafka 내부의 리스너에서 사용하는 포트 번호입니다. 포트 번호는 지정된 Kafka 클러스터 내에서 고유해야 합니다. 허용되는 포트 번호는 9092이고 포트 9404 및 9999를 제외하고 이미 Prometheus 및 10.0.0.1에 사용됩니다. 리스너 유형에 따라 포트 번호가 Kafka 클라이언트를 연결하는 포트 번호와 동일하지 않을 수 있습니다.

- 11

내부또는cluster-ip로 지정된 리스너 유형(broker별ClusterIP서비스를 사용하여 Kafka를 노출) 또는 외부 리스너의 경우경로(OpenShift만), 로드 밸런서,노드 포트또는수신(Kubernetes만 해당)으로 지정됩니다.- 12

- 각 리스너에 대해 TLS 암호화를 활성화합니다. 기본값은

false입니다.경로리스너에는 TLS 암호화가 필요하지 않습니다. - 13

- 클러스터 서비스 접미사(일반적으로

.cluster.local)를 포함한 정규화된 DNS 이름이 할당되는지 여부를 정의합니다. - 14

- mTLS, SCRAM-SHA-512 또는 토큰 기반 OAuth 2.0으로 지정된 리스너 인증 메커니즘.

- 15

- 외부 리스너 구성은

경로,loadbalancer또는nodeport를 통해 Kafka 클러스터가 OpenShift 외부에 노출되는 방법을 지정합니다. - 16

- 외부 CA(인증 기관)에서 관리하는 Kafka 리스너 인증서에 대한 선택적 구성입니다.

brokerCertECDHEAndKey는 서버 인증서와 개인 키가 포함된 보안을 지정합니다.활성화된 TLS 암호화를 사용하여 모든 리스너에서 Kafka 리스너 인증서를 구성할 수 있습니다. - 17

- 권한 부여 를 사용하면 Kafka 브로커에서 간단한 OAUTH 2.0 또는 OPA 인증을 사용할 수 있습니다. 간단한 인증에서는

AclAuthorizerKafka 플러그인을 사용합니다. - 18

- 19

- 20

- 21

- 22

- 영구 스토리지에는 동적 볼륨 프로비저닝을 위한 스토리지 ID 및

클래스 - 23

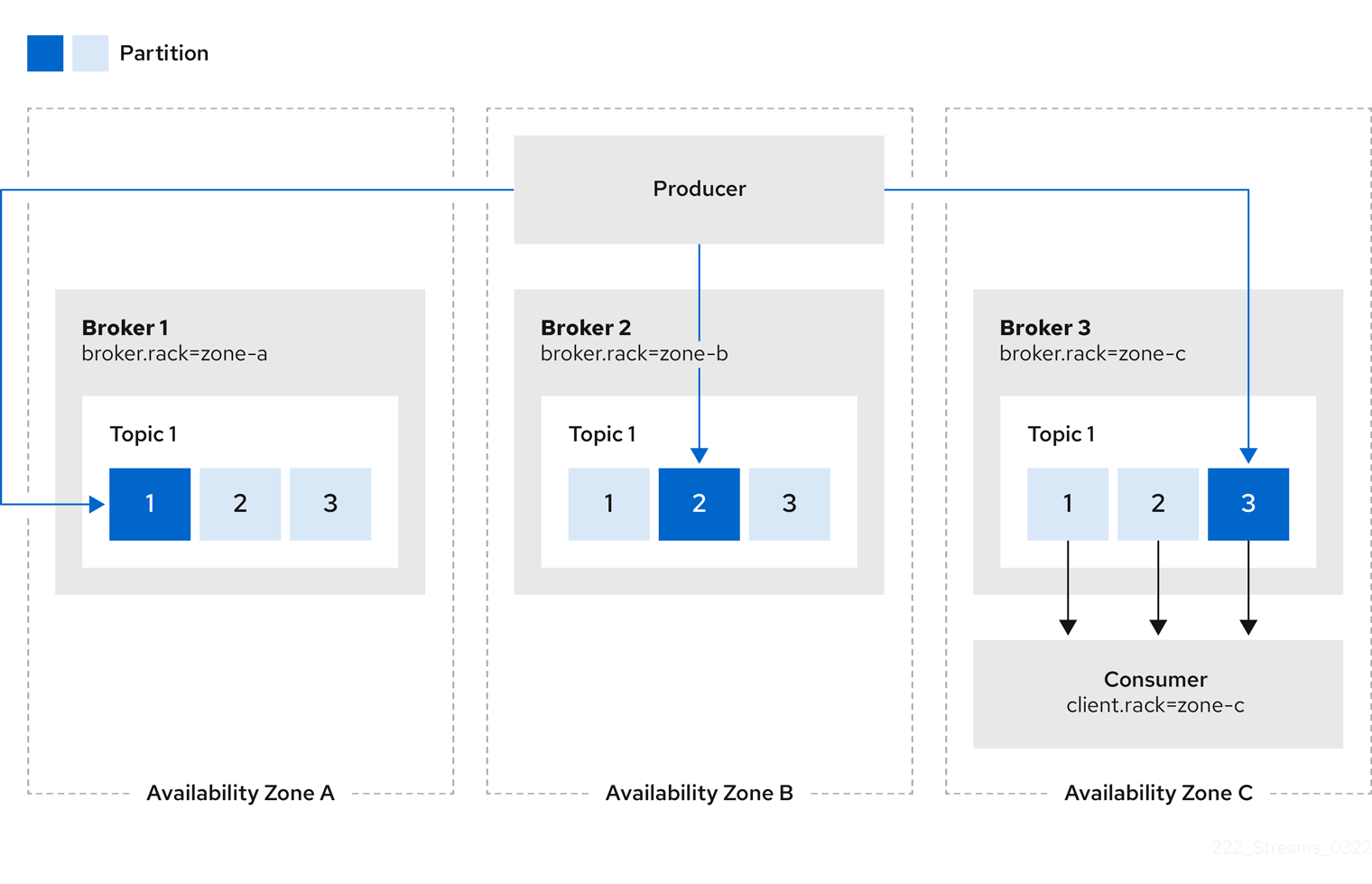

- 다양한 랙, 데이터 센터 또는 가용 영역에 복제본을 분산하기 위한 Rack 인식 구성입니다.

topologyKey는 rack ID가 포함된 노드 레이블과 일치해야 합니다. 이 구성에 사용된 예제에서는 표준topology.kubernetes.io/zone레이블을 사용하여 영역을 지정합니다. - 24

- Prometheus 지표 가 활성화되었습니다. 이 예에서는 Prometheus ScanSetting Exporter(기본 지표 내보내기)에 대한 지표가 구성됩니다.

- 25

- Prometheus exporter에 대한 구성이 포함된 ConfigMap을 참조하여 활성화되는 Prometheus dashboard를 통해 Grafana 대시보드로 메트릭을 내보내는 규칙입니다.

metricsConfig.valueFrom.configMapKeyRef.key아래에 빈 파일이 포함된 ConfigMap에 대한 참조를 사용하여 추가 구성 없이 메트릭을 활성화할 수 있습니다. - 26

- Kafka 구성과 유사한 속성을 포함하는 zookeeper-specific 구성입니다.

- 27

- ZooKeeper 노드 수입니다. zookeeper 클러스터 또는 ensembles는 일반적으로 홀수의 노드 (일반적으로 3, 5 또는 7)와 함께 실행됩니다. 효과적인 쿼럼을 유지하려면 대부분의 노드를 사용할 수 있어야 합니다. ZooKeeper 클러스터에서 쿼럼이 손실되면 클라이언트에 대한 응답이 중지되고 Kafka 브로커가 작동을 중지합니다. AMQ Streams에는 안정적이고 가용성이 높은 ZooKeeper 클러스터를 갖는 것이 중요합니다.

- 28

- 지정된 ZooKeeper 로거 및 로그 수준.

- 29

- 30

- 엔티티 Operator TLS 사이드카 구성. entity Operator는 TLS 사이드카를 사용하여 ZooKeeper와의 보안 통신을 지원합니다.

- 31

- 지정된 Topic Operator 로거 및 로그 수준. 이 예에서는

인라인로깅을 사용합니다. - 32

- 33

- Kafka 내보내기 구성. Kafka 내보내기 는 Kafka 브로커, 특히 소비자 지연 데이터에서 메트릭 데이터를 추출하는 선택적 구성 요소입니다. Kafka 내보내기가 제대로 작동하려면 소비자 그룹을 사용 중이어야 합니다.

- 34

- Kafka 클러스터를 재조정하는 데 사용되는 Cruise Control에 대한 선택적 구성입니다.

리소스를 생성하거나 업데이트합니다.

oc apply -f <kafka_configuration_file>

oc apply -f <kafka_configuration_file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.2. Entity Operator 구성

Entity Operator는 실행 중인 Kafka 클러스터에서 Kafka 관련 엔터티를 관리합니다.

Entity Operator는 다음을 포함합니다.

- Kafka 주제를 관리하기 위한 topic Operator

- Kafka 사용자를 관리하는 사용자 Operator

Kafka 리소스 구성을 통해 Cluster Operator는 Kafka 클러스터를 배포할 때 하나 또는 둘 다를 포함하여 Entity Operator를 배포할 수 있습니다.

Operator는 Kafka 클러스터의 주제와 사용자를 관리하도록 자동으로 구성됩니다. Topic Operator 및 User Operator는 단일 네임스페이스만 조사할 수 있습니다.

배포되면 Entity Operator Pod에는 배포 구성에 따라 Operator가 포함됩니다.

2.2.2.1. 엔터티 Operator 구성 속성

Kafka.spec 의 entityOperator 속성을 사용하여 Entity Operator를 구성합니다.

entityOperator 속성은 다음과 같은 여러 하위 속성을 지원합니다.

-

tlsSidecar -

topicOperator -

userOperator -

template

tlsSidecar 속성에는 ZooKeeper와 통신하는 데 사용되는 TLS 사이드카 컨테이너 구성이 포함되어 있습니다.

template 속성에는 레이블, 주석, 유사성, 허용 오차와 같은 Entity Operator Pod의 구성이 포함되어 있습니다. 템플릿 구성에 대한 자세한 내용은 2.7절. “OpenShift 리소스 사용자 정의” 을 참조하십시오.

topicOperator 속성에는 Topic Operator의 구성이 포함되어 있습니다. 이 옵션이 없으면 Entity Operator가 Topic Operator 없이 배포됩니다.

userOperator 속성에는 User Operator의 구성이 포함됩니다. 이 옵션이 없으면 User Operator 없이 Entity Operator가 배포됩니다.

Entity Operator를 구성하는 데 사용되는 속성에 대한 자세한 내용은 EntityUserOperatorSpec 스키마 참조 를 참조하십시오.

두 Operator를 모두 활성화하는 기본 구성의 예

topicOperator 및 userOperator 에 빈 오브젝트({})를 사용하는 경우 모든 속성은 기본값을 사용합니다.

topicOperator 및 userOperator 속성이 모두 누락되면 Entity Operator가 배포되지 않습니다.

2.2.2.2. 주제 Operator 구성 속성

topic Operator 배포는 topicOperator 오브젝트 내의 추가 옵션을 사용하여 구성할 수 있습니다. 지원되는 속성은 다음과 같습니다.

watchedNamespace-

주제 Operator가

KafkaTopic리소스를 조사하는 OpenShift 네임스페이스입니다. default는 Kafka 클러스터가 배포된 네임스페이스입니다. reconciliationIntervalSeconds-

정기적인 조정 간격(초)입니다. 기본값

120. zookeeperSessionTimeoutSeconds-

ZooKeeper 세션 시간 초과(초)입니다. 기본값

18. topicMetadataMaxAttempts-

Kafka에서 주제 메타데이터를 가져오는 시도 횟수입니다. 각 시도 사이의 시간은 지수 백오프로 정의됩니다. 파티션 또는 복제본 수로 인해 주제 생성에 시간이 더 걸릴 때 이 값을 늘리는 것이 좋습니다. 기본값

6. image-

image속성을 사용하여 사용할 컨테이너 이미지를 구성할 수 있습니다. 사용자 지정 컨테이너 이미지 구성에 대한 자세한 내용은 6.1.6절. “image” 을 참조하십시오. resources-

resources속성은 Topic Operator에 할당된 리소스 양을 구성합니다. 리소스 요청 및 제한 구성에 대한 자세한 내용은 6.1.5절. “resources” 을 참조하십시오. logging-

logging속성은 Topic Operator의 로깅을 구성합니다. 자세한 내용은 6.2.45.1절. “logging” 에서 참조하십시오.

주제 Operator 구성 예

2.2.2.3. 사용자 Operator 설정 속성

사용자 Operator 배포는 userOperator 오브젝트 내의 추가 옵션을 사용하여 구성할 수 있습니다. 지원되는 속성은 다음과 같습니다.

watchedNamespace-

User Operator가

KafkaUser리소스를 조사하는 OpenShift 네임스페이스입니다. default는 Kafka 클러스터가 배포된 네임스페이스입니다. reconciliationIntervalSeconds-

정기적인 조정 간격(초)입니다. 기본값

120. image-

image속성을 사용하여 사용할 컨테이너 이미지를 구성할 수 있습니다. 사용자 지정 컨테이너 이미지 구성에 대한 자세한 내용은 6.1.6절. “image” 을 참조하십시오. resources-

resources속성은 User Operator에 할당된 리소스 양을 구성합니다. 리소스 요청 및 제한 구성에 대한 자세한 내용은 6.1.5절. “resources” 을 참조하십시오. logging-

logging속성은 User Operator의 로깅을 구성합니다. 자세한 내용은 6.2.45.1절. “logging” 에서 참조하십시오. secretPrefix-

secretPrefix속성은 KafkaUser 리소스에서 생성한 모든 Secrets 이름에 접두사를 추가합니다. 예를 들어secretPrefix: kafka-는 모든 Secret 이름을kafka-로 접두사로 지정합니다. 따라서my-user라는 KafkaUser는kafka-my-user라는 시크릿을 생성합니다.

User Operator 구성 예

2.2.3. Kafka 및 ZooKeeper 스토리지 구성

스테이트풀 애플리케이션으로서 Kafka 및 ZooKeeper는 디스크에 데이터를 저장합니다. AMQ Streams는 이 데이터를 위한 세 가지 스토리지 유형을 지원합니다.

- 임시 (개발 전용 권장)

- 영구

- JBOD(축소가 아닌 Kafka )

Kafka 리소스를 구성할 때 Kafka 브로커와 해당 ZooKeeper 노드에서 사용하는 스토리지 유형을 지정할 수 있습니다. 다음 리소스의 storage 속성을 사용하여 스토리지 유형을 구성합니다.

-

Kafka.spec.kafka -

Kafka.spec.zookeeper

스토리지 유형은 type 필드에 구성됩니다.

스토리지 구성 속성에 대한 자세한 내용은 스키마 참조를 참조하십시오.

Kafka 클러스터를 배포한 후에는 스토리지 유형을 변경할 수 없습니다.

2.2.3.1. 데이터 스토리지 고려 사항

AMQ Streams가 제대로 작동하려면 효율적인 데이터 스토리지 인프라가 필요합니다. 블록 스토리지를 사용하는 것이 좋습니다. AMQ Streams는 블록 스토리지와의 사용만 테스트합니다. NFS와 같은 파일 스토리지는 테스트되지 않았으며 작동할 것이라는 보장이 없습니다.

블록 스토리지에 대해 다음 옵션 중 하나를 선택합니다.

- Amazon EBS(Elastic Block Store)와 같은 클라우드 기반 블록 스토리지 솔루션

- 로컬 영구 볼륨을 사용하는 영구스토리지

- 파이버 채널 또는 iSCSI와 같은 프로토콜에서 액세스하는 SAN(Storage Area Network) 볼륨

AMQ Streams에는 OpenShift 원시 블록 볼륨이 필요하지 않습니다.

2.2.3.1.1. 파일 시스템

Kafka는 메시지를 저장하는 데 파일 시스템을 사용합니다. AMQ Streams는 Kafka와 일반적으로 사용되는 XFS 및 ext4 파일 시스템과 호환됩니다. 파일 시스템을 선택하고 설정할 때 배포의 기본 아키텍처 및 요구 사항을 고려하십시오.

자세한 내용은 Kafka 문서의 파일 시스템 선택 항목을 참조하십시오.

2.2.3.1.2. 디스크 사용량

Apache Kafka 및 ZooKeeper에 대해 별도의 디스크를 사용합니다.

SSD(Solid-State Drive)는 필수는 아니지만 데이터가 비동기적으로 전송되고 수신되는 대규모 클러스터에서 Kafka의 성능을 향상시킬 수 있습니다. SSD는 짧은 대기 시간 데이터 액세스가 필요한 ZooKeeper에서 특히 유용합니다.

Kafka와 ZooKeeper 둘 다 데이터 복제가 내장되어 있기 때문에 복제된 스토리지를 프로비저닝할 필요가 없습니다.

2.2.3.2. 임시 스토리지

임시 데이터 스토리지는 일시적입니다. 노드의 모든 포드는 로컬 임시 스토리지 공간을 공유합니다. 이를 사용하는 Pod가 실행되는 동안 데이터는 유지됩니다. Pod가 삭제되면 데이터가 손실됩니다. Pod는 고가용성 환경에서 데이터를 복구할 수 있습니다.

일시적인 특성으로 인해 임시 스토리지는 개발 및 테스트에만 권장됩니다.

임시 스토리지는 emptyDir 볼륨을 사용하여 데이터를 저장합니다. emptyDir 볼륨은 Pod가 노드에 할당되면 생성됩니다. sizeLimit 속성을 사용하여 emptyDir 의 총 스토리지 양을 설정할 수 있습니다.

임시 스토리지는 복제 요소가 1인 단일 노드 ZooKeeper 클러스터 또는 Kafka 항목에 적합하지 않습니다.

임시 스토리지를 사용하려면 Kafka 또는 ZooKeeper 리소스의 스토리지 유형 구성을 임시 로 설정합니다.

임시 스토리지 구성 예

2.2.3.2.1. Kafka 로그 디렉터리의 마운트 경로

임시 볼륨은 Kafka 브로커가 다음 경로에 마운트된 로그 디렉터리로 사용합니다.

/var/lib/kafka/data/kafka-logIDX

/var/lib/kafka/data/kafka-logIDX

여기서 IDX 는 Kafka 브로커 Pod 인덱스입니다. 예: /var/lib/kafka/data/kafka-log0.

2.2.3.3. 영구 스토리지

영구 데이터 스토리지는 시스템 중단 시 데이터를 유지합니다. 영구 데이터 스토리지를 사용하는 Pod의 경우 Pod 실패 및 재시작 시 데이터가 유지됩니다.

동적 프로비저닝 프레임워크를 사용하면 영구 스토리지를 사용하여 클러스터를 생성할 수 있습니다. Pod 구성에서는 PVC( 영구 볼륨 클레임 )를 사용하여 PV(영구 볼륨)에서 스토리지 요청을 수행합니다. PV는 스토리지 볼륨을 나타내는 스토리지 리소스입니다. PV는 이를 사용하는 Pod와 독립적입니다. PVC는 Pod를 생성할 때 필요한 스토리지 양을 요청합니다. PV의 기본 스토리지 인프라를 인식할 필요가 없습니다. PV가 스토리지 기준과 일치하면 PVC가 PV에 바인딩됩니다.

영구 특성으로 인해 프로덕션에는 영구 스토리지를 사용하는 것이 좋습니다.

PVC는 StorageClass 를 지정하여 다른 유형의 영구 스토리지를 요청할 수 있습니다. 스토리지 클래스는 스토리지 프로필을 정의하고 PV를 동적으로 프로비저닝합니다. 스토리지 클래스를 지정하지 않으면 기본 스토리지 클래스가 사용됩니다. 영구 스토리지 옵션에는 SAN 스토리지 유형 또는 로컬 영구 볼륨이 포함될 수 있습니다.

영구 스토리지를 사용하려면 Kafka 또는 ZooKeeper 리소스의 스토리지 유형 구성을 persistent-claim 으로 설정합니다.

프로덕션 환경에서는 다음 구성을 사용하는 것이 좋습니다.

-

Kafka의 경우

type: persistent-claim볼륨으로 하나 이상의 유형으로 jbod -

ZooKeeper의 경우

type: persistent-claim을 구성합니다.

영구 스토리지에는 다음과 같은 구성 옵션도 있습니다.

ID(선택 사항)-

스토리지 식별 번호입니다. 이 옵션은 JBOD 스토리지 선언에 정의된 스토리지 볼륨에 필요합니다. 기본값은

0입니다. 크기(필수)- 영구 볼륨 클레임의 크기(예: "1000Gi").

클래스(선택 사항)-

동적 볼륨 프로비저닝에 사용할 OpenShift StorageClass 입니다. 스토리지

클래스구성에는 볼륨 프로필을 자세히 설명하는 매개변수가 포함되어 있습니다. 선택기(선택 사항)- 특정 PV를 지정하는 구성입니다. 선택한 볼륨의 레이블을 나타내는 key:value 쌍을 제공합니다.

DeleteClaim(선택 사항)-

클러스터가 제거될 때 PVC가 삭제되었는지 여부를 지정하는 부울 값입니다. 기본값은

false입니다.

기존 AMQ Streams 클러스터에서 영구 볼륨의 크기를 늘리는 것은 영구 볼륨 크기 조정을 지원하는 OpenShift 버전에서만 지원됩니다. 크기를 조정할 영구 볼륨에서는 볼륨 확장을 지원하는 스토리지 클래스를 사용해야 합니다. 볼륨 확장을 지원하지 않는 다른 OpenShift 및 스토리지 클래스 버전의 경우 클러스터를 배포하기 전에 필요한 스토리지 크기를 결정해야 합니다. 기존 영구 볼륨의 크기를 줄이는 것은 불가능합니다.

Kafka 및 ZooKeeper의 영구 스토리지 구성 예

스토리지 클래스를 지정하지 않으면 기본값이 사용됩니다. 다음 예제에서는 스토리지 클래스를 지정합니다.

특정 스토리지 클래스를 사용한 영구 스토리지 구성 예

선택기 를 사용하여 SSD와 같은 특정 기능을 제공하는 레이블이 지정된 영구 볼륨을 지정합니다.

선택기가 있는 영구 스토리지 구성의 예

2.2.3.3.1. 스토리지 클래스 덮어쓰기

기본 스토리지 클래스를 사용하는 대신 하나 이상의 Kafka 브로커 또는 ZooKeeper 노드에 대해 다른 스토리지 클래스를 지정할 수 있습니다. 예를 들어 스토리지 클래스가 다른 가용 영역 또는 데이터 센터로 제한되는 경우 유용합니다. 이를 위해 overrides 필드를 사용할 수 있습니다.

이 예제에서 기본 스토리지 클래스의 이름은 my-storage-class 입니다.

스토리지 클래스 덮어쓰기를 사용하는 AMQ Streams 클러스터의 예

구성된 덮어쓰기 속성을 통해 볼륨은 다음 스토리지 클래스를 사용합니다.

-

ZooKeeper 노드의 영구 볼륨 0은

my-storage-class-zone-1a를 사용합니다. -

ZooKeeper 노드 1의 영구 볼륨은

my-storage-class-zone-1b를 사용합니다. -

ZooKeeepr 노드 2의 영구 볼륨에서는

my-storage-class-zone-1c를 사용합니다. -

Kafka 브로커의 영구 볼륨 0은

my-storage-class-zone-1a를 사용합니다. -

Kafka 브로커 1의 영구 볼륨에서는

my-storage-class-zone-1b를 사용합니다. -

Kafka 브로커 2의 영구 볼륨에서는

my-storage-class-zone-1c를 사용합니다.

overrides 속성은 현재 스토리지 클래스 구성을 재정의하는 데만 사용됩니다. 다른 스토리지 구성 속성에 대한 덮어쓰기는 현재 지원되지 않습니다. 다른 스토리지 구성 속성은 현재 지원되지 않습니다.

2.2.3.3.2. 영구 스토리지를 위한 PVC 리소스

영구 스토리지를 사용하면 다음 이름으로 PVC를 생성합니다.

data-cluster-name-kafka-idx-

Kafka 브로커 Pod

idx에 대한 데이터를 저장하는 데 사용되는 볼륨의 PVC입니다. data-cluster-name-zookeeper-idx-

ZooKeeper 노드 Pod

idx에 대한 데이터를 저장하는 데 사용되는 볼륨의 PVC입니다.

2.2.3.3.3. Kafka 로그 디렉터리의 마운트 경로

영구 볼륨은 Kafka 브로커가 다음 경로에 마운트된 로그 디렉터리로 사용합니다.

/var/lib/kafka/data/kafka-logIDX

/var/lib/kafka/data/kafka-logIDX

여기서 IDX 는 Kafka 브로커 Pod 인덱스입니다. 예: /var/lib/kafka/data/kafka-log0.

2.2.3.4. 영구 볼륨 크기 조정

기존 AMQ Streams 클러스터에서 사용하는 영구 볼륨의 크기를 늘려 증가하는 스토리지 용량을 프로비저닝할 수 있습니다. JBOD 스토리지 구성에서 단일 영구 볼륨 또는 여러 영구 볼륨을 사용하는 클러스터에서 영구 볼륨 크기 조정이 지원됩니다.

영구 볼륨의 크기를 늘리지만 줄일 수는 없습니다. 영구 볼륨의 크기를 줄이는 것은 현재 OpenShift에서 지원되지 않습니다.

사전 요구 사항

- 볼륨 크기 조정을 지원하는 OpenShift 클러스터입니다.

- Cluster Operator가 실행 중입니다.

- 볼륨 확장을 지원하는 스토리지 클래스를 사용하여 생성된 영구 볼륨을 사용하는 Kafka 클러스터입니다.

절차

클러스터의

Kafka리소스를 편집합니다.Kafka 클러스터, ZooKeeper 클러스터 또는 둘 다에 할당된 영구 볼륨의 크기를 늘리도록

size속성을 변경합니다.-

Kafka 클러스터의 경우

spec.kafka.storage에서크기속성을 업데이트합니다. -

ZooKeeper 클러스터의 경우

spec.zookeeper.storage아래의크기속성을 업데이트합니다.

볼륨 크기를

2000Gi로 늘리기 위한 Kafka 구성Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

Kafka 클러스터의 경우

리소스를 생성하거나 업데이트합니다.

oc apply -f <kafka_configuration_file>

oc apply -f <kafka_configuration_file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift는 Cluster Operator의 요청에 대한 응답으로 선택한 영구 볼륨의 용량을 늘립니다. 크기 조정이 완료되면 Cluster Operator는 크기가 조정된 영구 볼륨을 사용하는 모든 Pod를 다시 시작합니다. 이 작업은 자동으로 수행됩니다.

클러스터의 관련 Pod에 대해 스토리지 용량이 증가했는지 확인합니다.

oc get pv

oc get pvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 스토리지 증가가 있는 Kafka 브로커 Pod

NAME CAPACITY CLAIM pvc-0ca459ce-... 2000Gi my-project/data-my-cluster-kafka-2 pvc-6e1810be-... 2000Gi my-project/data-my-cluster-kafka-0 pvc-82dc78c9-... 2000Gi my-project/data-my-cluster-kafka-1

NAME CAPACITY CLAIM pvc-0ca459ce-... 2000Gi my-project/data-my-cluster-kafka-2 pvc-6e1810be-... 2000Gi my-project/data-my-cluster-kafka-0 pvc-82dc78c9-... 2000Gi my-project/data-my-cluster-kafka-1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력에는 브로커 Pod와 연결된 각 PVC의 이름이 표시됩니다.

2.2.3.5. JBOD 스토리지

여러 디스크 또는 볼륨의 데이터 스토리지 구성인 JBOD를 사용하도록 AMQ Streams를 구성할 수 있습니다. JBOD는 Kafka 브로커를 위해 증가하는 데이터 스토리지를 제공하는 한 가지 방법입니다. 성능이 향상될 수도 있습니다.

JBOD 스토리지는 ZooKeeper가 아닌 Kafka에 대해서만 지원됩니다.

JBOD 구성은 하나 이상의 볼륨으로 설명되며 각 볼륨은 임시 또는 영구 볼륨이 될 수 있습니다. JBOD 볼륨 선언에 대한 규칙 및 제약 조건은 임시 및 영구 스토리지와 동일합니다. 예를 들어, 영구 스토리지 볼륨 크기를 프로비저닝한 후에는 줄일 수 없으며 유형이 임시 인 경우 sizeLimit 값을 변경할 수 없습니다.

JBOD 스토리지를 사용하려면 Kafka 리소스의 스토리지 유형 구성을 jbod 로 설정합니다. volumes 속성을 사용하면 JBOD 스토리지 어레이 또는 구성을 구성하는 디스크를 설명할 수 있습니다.

JBOD 스토리지 구성 예

JBOD 볼륨이 생성되면 ID를 변경할 수 없습니다. JBOD 구성에서 볼륨을 추가하거나 제거할 수 있습니다.

2.2.3.5.1. JBOD 스토리지용 PVC 리소스

영구 스토리지를 사용하여 JBOD 볼륨을 선언하면 다음 이름으로 PVC를 생성합니다.

data-id-cluster-name-kafka-idx-

Kafka 브로커 Pod

idx에 대한 데이터를 저장하는 데 사용되는 볼륨의 PVC입니다.id는 Kafka 브로커 Pod에 대한 데이터를 저장하는 데 사용되는 볼륨의 ID입니다.

2.2.3.5.2. Kafka 로그 디렉터리의 마운트 경로

JBOD 볼륨은 Kafka 브로커가 다음 경로에 마운트된 로그 디렉터리로 사용합니다.

/var/lib/kafka/data-id/kafka-logidx

/var/lib/kafka/data-id/kafka-logidx

여기서 id 는 Kafka 브로커 Pod idx 에 대한 데이터를 저장하는 데 사용되는 볼륨의 ID입니다. 예: /var/lib/kafka/data-0/kafka-log0.

2.2.3.6. JBOD 스토리지에 볼륨 추가

다음 절차에서는 JBOD 스토리지를 사용하도록 구성된 Kafka 클러스터에 볼륨을 추가하는 방법을 설명합니다. 다른 스토리지 유형을 사용하도록 구성된 Kafka 클러스터에 적용할 수 없습니다.

과거 및 제거된 ID 아래에 새 볼륨을 추가할 때 이전에 사용한 PersistentVolumeClaims 가 삭제되었는지 확인해야 합니다.

사전 요구 사항

- OpenShift 클러스터

- 실행 중인 Cluster Operator

- JBOD 스토리지가 있는 Kafka 클러스터

절차

Kafka리소스에서spec.kafka.storage.volumes속성을 편집합니다. volumes 배열에 새볼륨을추가합니다. 예를 들어 ID2가 포함된 새 볼륨을 추가합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 리소스를 생성하거나 업데이트합니다.

oc apply -f <kafka_configuration_file>

oc apply -f <kafka_configuration_file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 새 주제를 만들거나 기존 파티션을 새 디스크에 다시 할당합니다.

작은 정보Cruise Control은 파티션을 다시 할당하는 효과적인 도구입니다. Intra-broker 디스크 균형을 수행하려면

KafkaRebalance.spec에서rebalanceDisk를true로 설정합니다.

2.2.3.7. JBOD 스토리지에서 볼륨 제거

다음 절차에서는 JBOD 스토리지를 사용하도록 구성된 Kafka 클러스터에서 볼륨을 제거하는 방법을 설명합니다. 다른 스토리지 유형을 사용하도록 구성된 Kafka 클러스터에 적용할 수 없습니다. JBOD 스토리지는 항상 하나 이상의 볼륨을 포함해야 합니다.

데이터 손실을 방지하려면 볼륨을 제거하기 전에 모든 파티션을 이동해야합니다.

사전 요구 사항

- OpenShift 클러스터

- 실행 중인 Cluster Operator

- 두 개 이상의 볼륨이 있는 JBOD 스토리지가 있는 Kafka 클러스터

절차

제거할 디스크에서 모든 파티션을 다시 할당합니다. 제거하려는 디스크에 계속 할당된 파티션의 데이터는 손실될 수 있습니다.

작은 정보kafka-reassign-partitions.sh도구를 사용하여 파티션을 다시 할당할 수 있습니다.Kafka리소스에서spec.kafka.storage.volumes속성을 편집합니다. volumes 배열에서 하나 이상의볼륨을제거합니다. 예를 들어 ID1과2가 있는 볼륨을 제거합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 리소스를 생성하거나 업데이트합니다.

oc apply -f <kafka_configuration_file>

oc apply -f <kafka_configuration_file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.4. 터미널에서 ZooKeeper에 연결

대부분의 Kafka CLI 툴은 Kafka에 직접 연결할 수 있으므로 일반적인 상황에서는 ZooKeeper에 연결할 필요가 없습니다. zookeeper 서비스는 암호화 및 인증으로 보호되며 AMQ Streams에 포함되지 않은 외부 애플리케이션에서 사용할 수 없습니다.

그러나 ZooKeeper에 연결해야하는 Kafka CLI 도구를 사용하려면 ZooKeeper 컨테이너 내에서 터미널을 사용하고 ZooKeeper 주소로 localhost:12181 에 연결할 수 있습니다.

사전 요구 사항

- OpenShift 클러스터를 사용할 수 있습니다.

- Kafka 클러스터가 실행 중입니다.

- Cluster Operator가 실행 중입니다.

절차

OpenShift 콘솔을 사용하여 터미널을 열거나 CLI에서

exec명령을 실행합니다.예를 들면 다음과 같습니다.

oc exec -ti my-cluster-zookeeper-0 -- bin/kafka-topics.sh --list --zookeeper localhost:12181

oc exec -ti my-cluster-zookeeper-0 -- bin/kafka-topics.sh --list --zookeeper localhost:12181Copy to Clipboard Copied! Toggle word wrap Toggle overflow localhost:12181을 사용해야 합니다.이제 ZooKeeper에 Kafka 명령을 실행할 수 있습니다.

2.2.5. 수동으로 Kafka 노드 삭제

다음 절차에서는 OpenShift 주석을 사용하여 기존 Kafka 노드를 삭제하는 방법을 설명합니다. Kafka 노드를 삭제하면 Kafka 브로커가 실행 중인 Pod 와 관련 PersistentVolumeClaim (클러스터가 영구 스토리지와 함께 배포된 경우)을 모두 삭제해야 합니다. 삭제 후 Pod 및 관련 PersistentVolumeClaim 이 자동으로 다시 생성됩니다.

PersistentVolumeClaim 을 삭제하면 영구 데이터가 손실될 수 있습니다. 다음 절차는 스토리지 문제가 발생한 경우에만 수행해야 합니다.

사전 요구 사항

다음을 실행하는 방법에 대한 자세한 내용은 OpenShift에 AMQ Streams 배포 및 업그레이드 가이드를 참조하십시오.

절차

삭제할

Pod의 이름을 찾습니다.Kafka 브로커 Pod의 이름은 < cluster-name> -kafka- <index >입니다. 여기서 < index >는 0에서 시작하여 총 복제본 수에서 1을 뺀 값입니다. 예:

my-cluster-kafka-0.OpenShift에서

포드리소스에 주석을 답니다.oc annotate:oc annotate pod cluster-name-kafka-index strimzi.io/delete-pod-and-pvc=true

oc annotate pod cluster-name-kafka-index strimzi.io/delete-pod-and-pvc=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 다음 조정이 있을 때까지 기다린 후 기본 영구 볼륨 클레임을 사용하여 주석이 달린 Pod가 삭제되고 다시 생성됩니다.

2.2.6. ZooKeeper 노드 수동 삭제

다음 절차에서는 OpenShift 주석을 사용하여 기존 ZooKeeper 노드를 삭제하는 방법을 설명합니다. ZooKeeper 노드를 삭제하는 것은 ZooKeeper가 실행 중인 Pod 와 관련 PersistentVolumeClaim (영구 스토리지와 함께 배포된 경우)을 모두 삭제하는 것으로 구성됩니다. 삭제 후 Pod 및 관련 PersistentVolumeClaim 이 자동으로 다시 생성됩니다.

PersistentVolumeClaim 을 삭제하면 영구 데이터가 손실될 수 있습니다. 다음 절차는 스토리지 문제가 발생한 경우에만 수행해야 합니다.

사전 요구 사항

다음을 실행하는 방법에 대한 자세한 내용은 OpenShift에 AMQ Streams 배포 및 업그레이드 가이드를 참조하십시오.

절차

삭제할

Pod의 이름을 찾습니다.zookeeper Pod의 이름은 < cluster-name> -zookeeper- <index >입니다. 여기서 < index >는 0에서 시작하여 총 복제본 수에서 1을 뺀 값입니다. 예:

my-cluster-zookeeper-0.OpenShift에서

포드리소스에 주석을 답니다.oc annotate:oc annotate pod cluster-name-zookeeper-index strimzi.io/delete-pod-and-pvc=true

oc annotate pod cluster-name-zookeeper-index strimzi.io/delete-pod-and-pvc=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 다음 조정이 있을 때까지 기다린 후 기본 영구 볼륨 클레임을 사용하여 주석이 달린 Pod가 삭제되고 다시 생성됩니다.

2.2.7. Kafka 클러스터 리소스 목록

다음 리소스는 OpenShift 클러스터의 Cluster Operator에 의해 생성됩니다.

공유 리소스

cluster-name-cluster-ca- 클러스터 통신을 암호화하는 데 사용되는 Cluster CA 개인 키가 있는 시크릿입니다.

cluster-name-cluster-ca-cert- 클러스터 CA 공용 키가 있는 시크릿입니다. 이 키를 사용하여 Kafka 브로커의 ID를 확인할 수 있습니다.

cluster-name-clients-ca- 사용자 인증서에 서명하는 데 사용되는 클라이언트 CA 개인 키가 있는 시크릿

cluster-name-clients-ca-cert- 클라이언트 CA 공개 키가 있는 시크릿입니다. 이 키를 사용하여 Kafka 사용자의 ID를 확인할 수 있습니다.

cluster-name-cluster-operator-certs- Kafka 및 ZooKeeper와의 통신을 위한 클러스터 운영자 키가 있는 시크릿

zookeeper 노드

cluster-name-zookeeper다음 ZooKeeper 리소스에 지정된 이름입니다.

-

StrimziPodSet 또는 StatefulSet (

UseStrimziPodSets기능 게이트가 비활성화된 경우) ZooKeeper 노드 Pod를 관리합니다. - ZooKeeper 노드에서 사용하는 서비스 계정입니다.

- ZooKeeper 노드에 대해 구성된 PodDisruptionBudget입니다.

-

StrimziPodSet 또는 StatefulSet (

cluster-name-zookeeper-idx- ZooKeeper StatefulSet 또는 StrimziPodSet에서 생성한 Pod

cluster-name-zookeeper-nodes- Headless Service는 ZooKeeper Pod IP 주소를 직접 확인할 수 있어야 했습니다.

cluster-name-zookeeper-client- Kafka 브로커가 클라이언트로 ZooKeeper 노드에 연결하는 데 사용하는 서비스입니다.

cluster-name-zookeeper-config- ZooKeeper 보조 구성이 포함되어 있으며 ZooKeeper 노드 Pod에서 볼륨으로 마운트되는 ConfigMap입니다.

cluster-name-zookeeper-nodes- ZooKeeper 노드 키가 있는 시크릿입니다.

cluster-name-network-policy-zookeeper- ZooKeeper 서비스에 대한 액세스를 관리하는 네트워크 정책입니다.

data-cluster-name-zookeeper-idx-

ZooKeeper 노드 Pod

idx에 대한 데이터를 저장하는 데 사용되는 볼륨에 대한 영구 볼륨 클레임입니다. 이 리소스는 데이터를 저장할 영구 볼륨을 프로비저닝하기 위해 영구 스토리지가 선택된 경우에만 생성됩니다.

Kafka 브로커

cluster-name-kafka다음 Kafka 리소스에 지정된 이름입니다.

-

Kafka 브로커 Pod를 관리하기 위한 StrimziPodSet 또는 StatefulSet (

UseStrimziPodSets기능 게이트가 비활성화된 경우) - Kafka Pod에서 사용하는 서비스 계정입니다.

- Kafka 브로커에 대해 구성된 PodDisruptionBudget입니다.

-

Kafka 브로커 Pod를 관리하기 위한 StrimziPodSet 또는 StatefulSet (

cluster-name-kafka-idx다음 Kafka 리소스에 지정된 이름입니다.

- Kafka StatefulSet 또는 StrimziPodSet에서 생성한 Pod

-

Kafka 브로커 구성이 있는 ConfigMap (

UseStrimziPodSets기능 게이트가 활성화된 경우).

cluster-name-kafka-brokers- 서비스는 Kafka 브로커 Pod IP 주소를 직접 확인하도록 DNS가 필요합니다.

cluster-name-kafka-bootstrap- 서비스는 OpenShift 클러스터 내에서 연결하는 Kafka 클라이언트의 부트스트랩 서버로 사용할 수 있습니다.

cluster-name-kafka-external-bootstrap-

OpenShift 클러스터 외부에서 연결하는 클라이언트를 위한 부트스트랩 서비스입니다. 이 리소스는 외부 리스너가 활성화된 경우에만 생성됩니다. 리스너 이름이

외부이고 포트가9094인 경우 이전 서비스 이름이 이전 버전과의 호환성에 사용됩니다. cluster-name-kafka-pod-id-

OpenShift 클러스터 외부에서 개별 포드로 트래픽을 라우팅하는 데 사용되는 서비스입니다. 이 리소스는 외부 리스너가 활성화된 경우에만 생성됩니다. 리스너 이름이

외부이고 포트가9094인 경우 이전 서비스 이름이 이전 버전과의 호환성에 사용됩니다. cluster-name-kafka-external-bootstrap-

OpenShift 클러스터 외부에서 연결하는 클라이언트용 부트스트랩 경로입니다. 이 리소스는 외부 리스너가 활성화되고 유형

route로 설정된 경우에만 생성됩니다. 리스너 이름이외부이고 포트가9094인 경우 이전 경로 이름이 이전 버전과의 호환성에 사용됩니다. cluster-name-kafka-pod-id-

OpenShift 클러스터 외부에서 개별 포드로의 트래픽 경로입니다. 이 리소스는 외부 리스너가 활성화되고 유형

route로 설정된 경우에만 생성됩니다. 리스너 이름이외부이고 포트가9094인 경우 이전 경로 이름이 이전 버전과의 호환성에 사용됩니다. cluster-name-kafka-listener-name-bootstrap- OpenShift 클러스터 외부에서 연결하는 클라이언트를 위한 부트스트랩 서비스입니다. 이 리소스는 외부 리스너가 활성화된 경우에만 생성됩니다. 새 서비스 이름은 다른 모든 외부 리스너에 사용됩니다.

cluster-name-kafka-listener-name-pod-id- OpenShift 클러스터 외부에서 개별 포드로 트래픽을 라우팅하는 데 사용되는 서비스입니다. 이 리소스는 외부 리스너가 활성화된 경우에만 생성됩니다. 새 서비스 이름은 다른 모든 외부 리스너에 사용됩니다.

cluster-name-kafka-listener-name-bootstrap-

OpenShift 클러스터 외부에서 연결하는 클라이언트용 부트스트랩 경로입니다. 이 리소스는 외부 리스너가 활성화되고 유형

route로 설정된 경우에만 생성됩니다. 새 경로 이름은 다른 모든 외부 리스너에 사용됩니다. cluster-name-kafka-listener-name-pod-id-

OpenShift 클러스터 외부에서 개별 포드로의 트래픽 경로입니다. 이 리소스는 외부 리스너가 활성화되고 유형

route로 설정된 경우에만 생성됩니다. 새 경로 이름은 다른 모든 외부 리스너에 사용됩니다. cluster-name-kafka-config-

UseStrimziPodSets기능 게이트가 비활성화될 때 브로커 Pod에 의해 볼륨으로 마운트되는 Kafka 보조 구성이 포함된 ConfigMap cluster-name-kafka-brokers- Kafka 브로커 키가 있는 시크릿입니다.

cluster-name-network-policy-kafka- Kafka 서비스에 대한 액세스를 관리하는 네트워크 정책입니다.

strimzi-namespace-name-cluster-name-kafka-init- Kafka 브로커가 사용하는 클러스터 역할 바인딩입니다.

cluster-name-jmx- Kafka 브로커 포트를 보호하는 데 사용되는 사용자 이름 및 암호가 있는 시크릿입니다. 이 리소스는 Kafka에서 ScanSetting이 활성화된 경우에만 생성됩니다.

data-cluster-name-kafka-idx-

Kafka 브로커 Pod에 대한 데이터를 저장하는 데 사용되는 볼륨에 대한 영구 볼륨 클레임입니다.

이 리소스는 데이터를 저장하기 위해 영구 볼륨을 프로비저닝하기 위해 영구 스토리지가 선택된 경우에만 생성됩니다. data-id-cluster-name-kafka-idx-

Kafka 브로커 Pod

idx

엔터티 Operator

이러한 리소스는 Cluster Operator를 사용하여 Entity Operator를 배포하는 경우에만 생성됩니다.

cluster-name-entity-operator다음 Entity Operator 리소스에 지정된 이름입니다.

- 주제 및 사용자 Operator를 사용한 배포.

- Entity Operator에서 사용하는 서비스 계정입니다.

cluster-name-entity-operator-random-string- Entity Operator 배포에서 생성한 Pod입니다.

cluster-name-entity-topic-operator-config- 주제 Operator에 대한 보조 구성이 있는 ConfigMap입니다.

cluster-name-entity-user-operator-config- 사용자 Operator에 대한 보조 구성이 있는 ConfigMap입니다.

cluster-name-entity-topic-operator-certs- Kafka 및 ZooKeeper와의 통신을 위한 Topic Operator 키가 있는 시크릿입니다.

cluster-name-entity-user-operator-certs- Kafka 및 ZooKeeper와의 통신을 위한 User Operator 키가 있는 시크릿

strimzi-cluster-name-entity-topic-operator- Entity Topic Operator에서 사용하는 역할 바인딩입니다.

strimzi-cluster-name-entity-user-operator- Entity User Operator에서 사용하는 역할 바인딩입니다.

Kafka Exporter

이러한 리소스는 Cluster Operator를 사용하여 Kafka 내보내기를 배포하는 경우에만 생성됩니다.

cluster-name-kafka-exporter다음 Kafka Exporter 리소스에 지정된 이름입니다.

- Kafka 내보내기를 통한 배포.

- 소비자 지연 메트릭을 수집하는 데 사용되는 서비스입니다.

- Kafka 내보내기에서 사용하는 서비스 계정입니다.

cluster-name-kafka-exporter-random-string- Kafka 내보내기 배포에서 생성한 Pod입니다.

크루즈 컨트롤

이러한 리소스는 Cluster Operator를 사용하여 Cruise Control을 배포한 경우에만 생성됩니다.

cluster-name-cruise-control다음 Cruise Control 리소스에 지정된 이름입니다.

- Cruise Control을 사용한 배포.

- Cruise Control과 통신하는 데 사용되는 서비스입니다.

- Cruise Control에서 사용하는 서비스 계정입니다.

cluster-name-cruise-control-random-string- Cruise Control Deployment에서 생성한 Pod

cluster-name-cruise-control-config- Cruise Control ancillary 구성이 포함되어 있으며 Cruise Control Pod에서 볼륨으로 마운트되는 ConfigMap입니다.

cluster-name-cruise-control-certs- Kafka 및 ZooKeeper와의 통신을 위한 Cruise Control 키가 있는 시크릿입니다.

cluster-name-network-policy-cruise-control- Cruise Control Service에 대한 액세스를 관리하는 네트워크 정책입니다.

2.3. Kafka Connect 클러스터 구성

KafkaConnect 리소스를 사용하여 Kafka Connect 배포를 구성합니다. Kafka Connect는 커넥터 플러그인을 사용하여 Kafka 브로커와 기타 시스템 간에 데이터를 스트리밍하기 위한 통합 툴킷입니다. Kafka Connect는 커넥터를 사용하여 데이터를 가져오거나 내보내기 위해 데이터베이스 등의 외부 데이터 소스 또는 대상과 Kafka를 통합하기 위한 프레임워크를 제공합니다. 커넥터는 필요한 연결 구성을 제공하는 플러그인입니다.

6.2.61절. “KafkaConnect 스키마 참조” KafkaConnect 리소스의 전체 스키마를 설명합니다.

커넥터 플러그인 배포에 대한 자세한 내용은 커넥터 플러그인 을 사용하여 Kafka Connect 확장을 참조하십시오.

2.3.1. Kafka Connect 구성

Kafka Connect를 사용하여 Kafka 클러스터에 대한 외부 데이터 연결을 설정합니다. KafkaConnect 리소스의 속성을 사용하여 Kafka Connect 배포를 구성합니다.

KafkaConnector 구성

KafkaConnector 리소스를 사용하면 OpenShift 네이티브 방식으로 Kafka Connect에 대한 커넥터 인스턴스를 생성하고 관리할 수 있습니다.

Kafka Connect 구성에서 strimzi.io/use-connector-resources 주석을 추가하여 Kafka Connect 클러스터에 KafkaConnectors를 활성화합니다. AMQ Streams가 데이터 연결에 필요한 커넥터 플러그인으로 컨테이너 이미지를 자동으로 빌드하도록 빌드 구성을 추가할 수도 있습니다. Kafka Connect 커넥터의 외부 구성은 externalConfiguration 속성을 통해 지정됩니다.

커넥터를 관리하려면 KafkaConnector 사용자 지정 리소스 또는 Kafka Connect REST API를 사용할 수 있습니다. KafkaConnector 리소스를 연결하는 Kafka Connect 클러스터와 동일한 네임스페이스에 배포해야 합니다. 이러한 방법을 사용하여 커넥터를 생성, 재구성 또는 삭제하는 방법에 대한 자세한 내용은 커넥터 추가 를 참조하십시오.

커넥터 구성은 HTTP 요청의 일부로 Kafka Connect에 전달되고 Kafka 자체 내에 저장됩니다. ConfigMaps 및 Secrets는 구성 및 기밀 데이터를 저장하는 데 사용되는 표준 OpenShift 리소스입니다. ConfigMaps 및 Secrets를 사용하여 커넥터의 특정 요소를 구성할 수 있습니다. 그런 다음 필요한 경우 구성을 별도로 보다 안전하게 유지하는 HTTP REST 명령에서 구성 값을 참조할 수 있습니다. 이 방법은 사용자 이름, 암호 또는 인증서와 같은 기밀 데이터에 특히 적용됩니다.

대량의 메시지 처리

대량의 메시지를 처리하도록 구성을 조정할 수 있습니다. 자세한 내용은 대량 의 메시지 처리를 참조하십시오.

사전 요구 사항

- OpenShift 클러스터

- 실행 중인 Cluster Operator

다음을 실행하는 방법에 대한 자세한 내용은 OpenShift에 AMQ Streams 배포 및 업그레이드 가이드를 참조하십시오.

절차

KafkaConnect리소스의spec속성을 편집합니다.구성할 수 있는 속성은 다음 예제 구성에 표시되어 있습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

KafkaConnect를 사용합니다.- 2

- Kafka Connect 클러스터의 KafkaConnectors를 활성화합니다.

- 3

- 작업을 실행하는 작업자 의 복제본 노드 수입니다.

- 4

- Kafka Connect 클러스터에 대한 인증: mTLS,토큰 기반 OAuth, SASL 기반 SCRAM 기반 SCRAM-256/SCRAM-SHA -512, 또는 PLAIN 으로 지정됩니다. 기본적으로 Kafka Connect는 일반 텍스트 연결을 사용하여 Kafka 브로커에 연결합니다.

- 5

- Kafka Connect 클러스터에 연결하기 위한 부트스트랩 서버 입니다.

- 6

- TLS 인증서가 클러스터의 X.509 형식으로 저장되는 키 이름을 사용한 TLS 암호화 입니다. 인증서가 동일한 보안에 저장된 경우 여러 번 나열할 수 있습니다.

- 7

- Kafka Connect 작업자 구성 (연결이 아님). 표준 Apache Kafka 구성을 제공하여 AMQ Streams에서 직접 관리하지 않는 속성으로 제한될 수 있습니다.

- 8

- 커넥터 플러그인이 자동으로 컨테이너 이미지를 빌드하기 위한 구성 속성을 빌드 합니다.

- 9

- (필수) 새 이미지가 푸시되는 컨테이너 레지스트리의 설정(필수)입니다.

- 10

- (필수) 새 컨테이너 이미지에 추가할 커넥터 플러그인 및 아티팩트 목록. 각 플러그인은 하나 이상의

아티팩트로 구성해야 합니다. - 11

- 12

- 13

- 지정된 Kafka Connect 로거 및 로그 수준은 ConfigMap을 통해 직접 (

인라인) 또는 간접적으로(외부)합니다. 사용자 지정 ConfigMap은log4j.properties또는log4j2.properties키에 배치해야 합니다. Kafka Connectlog4j.rootLogger로거의 경우 로그 수준을 INFO, ERROR, WARN, TRACE, DEBUG, FATAL 또는 OFF로 설정할 수 있습니다. - 14

- 컨테이너(liveness)를 다시 시작할 시기와 컨테이너가 트래픽을 수락할 수 있는 시기(가용성)를 확인할 수 있는 상태 점검 입니다.

- 15

- Prometheus 지표: 이 예제에서 Prometheus exporter에 대한 구성이 포함된 ConfigMap을 참조하여 활성화합니다.

metricsConfig.valueFrom.configMapKeyRef.key아래에 빈 파일이 포함된 ConfigMap에 대한 참조를 사용하여 추가 구성 없이 메트릭을 활성화할 수 있습니다. - 16

- Kafka Connect 를 실행하는 VM(가상 머신)의 성능을 최적화하는 JVM 구성 옵션입니다.

- 17

- ADVANCED OPTION : 컨테이너 이미지 구성.이는 특별한 경우에만 권장됩니다.

- 18

- SPECIALIZED OPTION: 배포에 대한 인식 인식 구성입니다. 이는 리전이 아닌 동일한 위치 내의 배포를 위한 특수 옵션입니다. 리더 복제본이 아닌 가장 가까운 복제본에서 커넥터를 소비하려면 이 옵션을 사용합니다. 경우에 따라 가장 가까운 복제본에서 소비하면 네트워크 사용률을 향상시키거나 비용을 줄일 수 있습니다.

topologyKey는 rack ID가 포함된 노드 레이블과 일치해야 합니다. 이 구성에 사용된 예제에서는 표준topology.kubernetes.io/zone레이블을 사용하여 영역을 지정합니다. 가장 가까운 복제본에서 사용하려면 Kafka 브로커 구성에서RackAwareReplicaSelector를 활성화합니다. - 19

- 템플릿 사용자 지정. 여기에서 Pod는 유사성 방지로 예약되므로 Pod는 동일한 호스트 이름이 있는 노드에 예약되지 않습니다.

- 20

- 환경 변수는 분산 추적을 위해 설정됩니다.

리소스를 생성하거나 업데이트합니다.

oc apply -f KAFKA-CONNECT-CONFIG-FILE

oc apply -f KAFKA-CONNECT-CONFIG-FILECopy to Clipboard Copied! Toggle word wrap Toggle overflow - Kafka Connect에 대한 인증이 활성화된 경우 Kafka Connect 소비자 그룹 및 항목에 대한 액세스를 활성화하도록 Kafka Connect 사용자를 구성합니다.

2.3.2. 여러 인스턴스에 대한 Kafka Connect 구성

Kafka Connect의 여러 인스턴스를 실행하는 경우 다음 구성 속성의 기본 구성을 변경해야 합니다.

세 항목의 값은 동일한 group.id 가 있는 모든 Kafka Connect 인스턴스에 대해 동일해야 합니다.

기본 설정을 변경하지 않으면 동일한 Kafka 클러스터에 연결하는 각 Kafka Connect 인스턴스가 동일한 값으로 배포됩니다. 실제로 모든 인스턴스가 클러스터에서 실행되고 동일한 주제를 사용하도록 연결된 것입니다.

여러 Kafka Connect 클러스터가 동일한 주제를 사용하려고 하면 Kafka Connect가 예상대로 작동하지 않고 오류를 생성합니다.

여러 Kafka Connect 인스턴스를 실행하려면 각 인스턴스에 대해 이러한 속성의 값을 변경합니다.

2.3.3. Kafka Connect 사용자 권한 부여 구성

다음 절차에서는 Kafka Connect에 대한 사용자 액세스 권한을 부여하는 방법을 설명합니다.

Kafka에서 권한 부여 유형을 사용하는 경우 Kafka Connect 사용자는 소비자 그룹 및 Kafka Connect의 내부 항목에 대한 읽기/쓰기 액세스 권한이 필요합니다.

소비자 그룹 및 내부 주제의 속성은 AMQ Streams에 의해 자동으로 구성되거나 KafkaConnect 리소스의 사양에 명시적으로 지정할 수 있습니다.

KafkaConnect 리소스의 설정 속성 예

다음 절차에서는 간단한 권한 부여를 사용할 때 액세스를 제공하는 방법을 설명합니다.

간단한 권한 부여에서는 Kafka AclAuthorizer 플러그인에서 처리하는 ACL 규칙을 사용하여 적절한 액세스 수준을 제공합니다. 간단한 권한을 사용하도록 KafkaUser 리소스를 구성하는 방법에 대한 자세한 내용은 AclRule 스키마 참조 를 참조하십시오.

소비자 그룹 및 주제의 기본값은 여러 인스턴스를 실행할 때 다릅니다.

사전 요구 사항

- OpenShift 클러스터

- 실행 중인 Cluster Operator

절차

KafkaUser리소스에서authorization속성을 편집하여 사용자에게 액세스 권한을 제공합니다.다음 예제에서는

리터럴이름 값을 사용하여 Kafka Connect 주제 및 소비자 그룹에 대한 액세스 권한이 구성됩니다.Expand 속성 이름 offset.storage.topicconnect-cluster-offsetsstatus.storage.topicconnect-cluster-statusconfig.storage.topicconnect-cluster-configsgroupconnect-clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 리소스를 생성하거나 업데이트합니다.

oc apply -f KAFKA-USER-CONFIG-FILE

oc apply -f KAFKA-USER-CONFIG-FILECopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.4. Kafka Connect 클러스터 리소스 목록

다음 리소스는 OpenShift 클러스터의 Cluster Operator에 의해 생성됩니다.

- connect-cluster-name-connect

다음 Kafka Connect 리소스에 지정된 이름입니다.

-

Kafka Connect 작업자 노드 Pod를 생성하는 배포(

StableConnectIdentities기능 게이트가 비활성화된 경우). -

Kafka Connect 작업자 노드 Pod를 생성하는 StrimziPodSet(

StableConnectIdentities기능 게이트가 활성화된 경우). -

Connect Pod에 안정적인 DNS 이름을 제공하는 헤드리스 서비스(

StableConnectIdentities기능 게이트가 활성화된 경우) - Kafka Connect 작업자 노드에 대해 구성된 Pod 중단 예산입니다.

-

Kafka Connect 작업자 노드 Pod를 생성하는 배포(

- connect-cluster-name-connect-idx

-

Kafka Connect StrimziPodSet에서 생성한 Pod(

StableConnectIdentities기능 게이트가 활성화된 경우) - connect-cluster-name-connect-api

- Kafka Connect 클러스터를 관리하기 위한 REST 인터페이스를 노출하는 서비스입니다.

- connect-cluster-name-config

- Kafka Connect 보조 구성이 포함되어 있고 Kafka 브로커 Pod에서 볼륨으로 마운트되는 ConfigMap입니다.

2.3.5. 변경 데이터 캡처를 위해 Red Hat build of Debezium과 통합

Red Hat build of Debezium은 분산 변경 데이터 캡처 플랫폼입니다. 데이터베이스의 행 수준 변경 사항을 캡처하고, 변경 이벤트 레코드를 생성하며, 해당 레코드를 Kafka 주제로 스트리밍합니다. Debezium은 Apache Kafka를 기반으로 합니다. Debezium의 Red Hat 빌드를 배포하고 AMQ Streams와 통합할 수 있습니다. AMQ Streams를 배포한 후 Kafka Connect를 통해 Debezium을 커넥터 구성으로 배포합니다. Debezium은 변경 이벤트 레코드를 OpenShift의 AMQ Streams에 전달합니다. 애플리케이션은 이러한 변경 이벤트 스트림을 읽고 발생한 순서대로 변경 이벤트에 액세스할 수 있습니다.

Debezium에는 다음과 같은 여러 용도가 있습니다.

- 데이터 복제

- 캐시 및 검색 인덱스 업데이트

- 모놀리식 애플리케이션 간소화

- 데이터 통합

- 스트리밍 쿼리 활성화

데이터베이스 변경 사항을 캡처하려면 Debezium 데이터베이스 커넥터를 사용하여 Kafka Connect를 배포합니다. 커넥터 인스턴스를 정의하도록 KafkaConnector 리소스를 구성합니다.

AMQ Streams를 사용하여 Debezium의 Red Hat 빌드 배포에 대한 자세한 내용은 제품 설명서 를 참조하십시오. 이 문서에는 데이터베이스 업데이트에 대한 변경 이벤트 레코드를 보는 데 필요한 서비스 및 커넥터 설정 프로세스를 안내하는 Debezium 시작하기 가이드가 포함되어 있습니다.

2.4. Kafka MirrorMaker 2 클러스터 구성

KafkaMirrorMaker2 리소스를 사용하여 Kafka MirrorMaker 2 배포를 구성합니다. MirrorMaker 2는 데이터 센터 내 또는 여러 Kafka 클러스터 간에 데이터를 복제합니다.

6.2.128절. “KafkaMirrorMaker2 스키마 참조” KafkaMirrorMaker2 리소스의 전체 스키마를 설명합니다.

MirrorMaker 2 리소스 구성은 이전 버전의 MirrorMaker와 다릅니다. MirrorMaker 2를 사용하도록 선택한 경우 현재 레거시 지원이 없으므로 모든 리소스를 새 형식으로 수동으로 변환해야 합니다.

2.4.1. MirrorMaker 2 데이터 복제

클러스터 전체의 데이터 복제에서는 다음이 필요한 시나리오를 지원합니다.

- 시스템 장애가 발생할 경우 데이터 복구

- 분석을 위한 데이터 집계

- 특정 클러스터에 대한 데이터 액세스 제한

- 대기 시간을 개선하기 위해 특정 위치에서 데이터 제공

2.4.1.1. MirrorMaker 2 구성

MirrorMaker 2는 소스 Kafka 클러스터의 메시지를 사용하여 대상 Kafka 클러스터에 씁니다.

MirrorMaker 2 사용:

- 소스 클러스터의 데이터를 사용하기 위한 소스 클러스터 구성

- 대상 클러스터로 데이터를 출력하는 대상 클러스터 구성

MirrorMaker 2는 Kafka Connect 프레임워크를 기반으로 하며 클러스터 간 데이터 전송을 관리하는 커넥터 입니다.

소스 및 대상 클러스터의 연결 세부 정보를 포함하여 Kafka Connect 배포를 정의하도록 MirrorMaker 2를 구성한 다음 일련의 MirrorMaker 2 커넥터를 실행하여 연결을 수행합니다.

MirrorMaker 2는 다음 커넥터로 구성됩니다.

MirrorSourceConnector-

소스 커넥터는 소스 클러스터에서 대상 클러스터로 항목을 복제합니다. 또한 ACL을 복제하며

MirrorCheckpointConnector를 실행하는 데 필요합니다. MirrorCheckpointConnector- 체크포인트 커넥터는 오프셋을 주기적으로 추적합니다. 활성화된 경우 소스 클러스터와 대상 클러스터 간의 소비자 그룹 오프셋도 동기화합니다.

MirrorHeartbeatConnector- 하트비트 커넥터는 소스 클러스터와 대상 클러스터 간의 연결을 주기적으로 확인합니다.

User Operator를 사용하여 ACL을 관리하는 경우 커넥터를 통해 ACL을 복제할 수 없습니다.

소스 클러스터에서 대상 클러스터로 데이터를 미러링 하는 프로세스는 비동기식입니다. 각 MirrorMaker 2 인스턴스는 하나의 소스 클러스터에서 하나의 대상 클러스터로 데이터를 미러링합니다. 둘 이상의 MirrorMaker 2 인스턴스를 사용하여 여러 클러스터 간에 데이터를 미러링할 수 있습니다.

그림 2.1. 두 클러스터에서 복제

기본적으로 소스 클러스터의 새 주제를 10분마다 점검합니다. 소스 커넥터 구성에 refresh.topics.interval.seconds 를 추가하여 빈도를 변경할 수 있습니다.

2.4.1.1.1. 클러스터 구성

MirrorMaker 2는 활성/수동 또는 활성 / 활성 클러스터 구성에서 사용할 수 있습니다.

- 활성/활성 클러스터 구성

- 활성/활성 구성에는 데이터를 양방향으로 복제하는 두 개의 활성 클러스터가 있습니다. 애플리케이션은 클러스터 중 하나를 사용할 수 있습니다. 각 클러스터는 동일한 데이터를 제공할 수 있습니다. 이러한 방식으로 서로 다른 지리적 위치에서 동일한 데이터를 사용할 수 있습니다. 소비자 그룹은 두 클러스터에서 모두 활성화되므로 복제된 항목에 대한 소비자 오프셋은 소스 클러스터와 다시 동기화되지 않습니다.

- 활성/수동 클러스터 구성

- Active/passive 구성에는 활성 클러스터 복제 데이터가 패시브 클러스터에 있습니다. 패시브 클러스터는 state에 남아 있습니다. 시스템 장애가 발생할 경우 데이터 복구에 수동 클러스터를 사용할 수 있습니다.

생산자와 소비자는 활성 클러스터에만 연결됩니다. 각 대상 대상에는 MirrorMaker 2 클러스터가 필요합니다.

2.4.1.1.2. 양방향 복제(활성/활성)

MirrorMaker 2 아키텍처는 활성/활성 클러스터 구성에서 양방향 복제를 지원합니다.

각 클러스터는 소스 및 원격 주제의 개념을 사용하여 다른 클러스터의 데이터를 복제합니다. 각 클러스터에 동일한 항목이 저장되므로 원격 주제의 이름을 MirrorMaker 2가 소스 클러스터를 나타내기 위해 자동으로 변경합니다. 원래 클러스터의 이름이 주제 이름 앞에 추가됩니다.

그림 2.2. 주제 이름 변경

원래 클러스터를 플래그하여 항목이 해당 클러스터로 다시 복제되지 않습니다.

원격 주제를 통한 복제 개념은 데이터 집계가 필요한 아키텍처를 구성할 때 유용합니다. 소비자는 별도의 집계 클러스터를 사용하지 않고도 동일한 클러스터 내의 소스 및 원격 주제를 구독할 수 있습니다.

2.4.1.1.3. Unidirectional 복제(활성/수동)

MirrorMaker 2 아키텍처는 활성/수동 클러스터 구성에서 단방향 복제를 지원합니다.

활성/수동 클러스터 구성을 사용하여 백업을 수행하거나 데이터를 다른 클러스터로 마이그레이션할 수 있습니다. 이 경우 원격 주제의 자동 이름 변경을 수행하지 않을 수 있습니다.

소스 커넥터 구성에 IdentityReplicationPolicy 를 추가하여 자동 이름 변경 사항을 덮어쓸 수 있습니다. 이 구성을 적용하면 주제는 원래 이름을 유지합니다.

2.4.1.2. 주제 구성 동기화

MirrorMaker 2는 소스 클러스터와 대상 클러스터 간의 주제 구성 동기화를 지원합니다. MirrorMaker 2 구성에 소스 주제를 지정합니다. MirrorMaker 2는 소스 주제를 모니터링합니다. MirrorMaker 2는 변경 사항을 감지하여 소스 주제의 원격 항목에 전파합니다. 변경 사항에는 누락된 주제 및 파티션을 자동으로 생성하는 작업이 포함될 수 있습니다.

대부분의 경우 로컬 항목에 작성하고 원격 주제에서 읽습니다. 원격 주제에서 쓰기 작업을 방지할 수는 없지만 피해야 합니다.

2.4.1.3. 오프셋 추적

MirrorMaker 2는 내부 주제를 사용하는 소비자 그룹에 대한 오프셋을 추적합니다.

offset-syncs주제-

offset-syncs주제는 레코드 메타데이터에서 복제된 주제 파티션에 대한 소스 및 대상 오프셋을 매핑합니다. 체크포인트주제-

체크포인트항목은 각 소비자 그룹에서 복제된 주제 파티션에 대해 소스 및 대상 클러스터에 마지막으로 커밋된 오프셋을 매핑합니다.

MirrorMaker 2에서 내부적으로 사용했기 때문에 이러한 주제와 직접 상호 작용하지 않습니다.

MirrorCheckpointConnector 는 오프셋 추적을 위한 체크포인트 를 출력합니다. 체크포인트 항목에 대한 오프셋은 구성을 통해 사전 결정된 간격으로 추적됩니다. 두 항목 모두 장애 조치의 올바른 오프셋 위치에서 복제를 완전히 복원할 수 있도록 합니다.

offset-syncs 주제의 위치는 기본적으로 소스 클러스터입니다. offset-syncs.topic.location 커넥터 구성을 사용하여 이를 대상 클러스터로 변경할 수 있습니다. 주제가 포함된 클러스터에 대한 읽기/쓰기 액세스 권한이 필요합니다. 대상 클러스터를 offset-syncs 주제의 위치로 사용하면 소스 클러스터에 대한 읽기 액세스 권한만 있는 경우에도 MirrorMaker 2를 사용할 수 있습니다.

2.4.1.4. 소비자 그룹 오프셋 동기화

__consumer_offsets 주제에서는 각 소비자 그룹에 대해 커밋된 오프셋에 대한 정보를 저장합니다. 오프셋 동기화는 소스 클러스터의 소비자 그룹에 대한 소비자 오프셋을 대상 클러스터의 소비자 오프셋 주제로 주기적으로 전송합니다.

오프셋 동기화는 활성/수동 구성에서 특히 유용합니다. 활성 클러스터가 다운되면 소비자 애플리케이션은 수동(standby) 클러스터로 전환하고 마지막으로 전송된 오프셋 위치에서 가져올 수 있습니다.

주제 오프셋 동기화를 사용하려면 checkpoint 커넥터 구성에 sync.group.offsets.enabled 를 추가하고 속성을 true 로 설정하여 동기화를 활성화합니다. 동기화는 기본적으로 비활성화되어 있습니다.

소스 커넥터에서 IdentityReplicationPolicy 를 사용하는 경우 검사점 커넥터 구성에서도 구성해야 합니다. 이렇게 하면 미러링된 소비자 오프셋이 올바른 항목에 적용됩니다.

소비자 오프셋은 대상 클러스터에서 활성 상태가 아닌 소비자 그룹에 대해서만 동기화됩니다. 소비자 그룹이 대상 클러스터에 있는 경우 동기화를 수행할 수 없으며 UNKNOWN_MEMBER_ID 오류가 반환됩니다.

활성화된 경우 소스 클러스터에서 오프셋의 동기화가 주기적으로 수행됩니다. sync.group.offsets.interval.seconds 및 emit.checkpoints.interval.seconds 를 checkpoint 커넥터 구성에 추가하여 빈도를 변경할 수 있습니다. 속성은 소비자 그룹 오프셋이 동기화되는 빈도와 오프셋 추적에 대해 출력되는 체크포인트 빈도를 초 단위로 지정합니다. 두 속성의 기본값은 60초입니다. 기본적으로 10분마다 수행되는 refresh.groups.interval.seconds 속성을 사용하여 새 소비자 그룹에 대한 검사 빈도를 변경할 수도 있습니다.

동기화는 시간 기반이므로 소비자가 수동 클러스터로 전환하면 메시지가 일부 복제될 수 있습니다.

Java로 작성된 애플리케이션이 있는 경우 RemoteClusterUtils.java 유틸리티를 사용하여 애플리케이션을 통해 오프셋을 동기화할 수 있습니다. 유틸리티는 체크포인트 주제에서 소비자 그룹에 대한 원격 오프셋을 가져옵니다.

2.4.1.5. 연결 확인

MirrorHeartbeatConnector 는 클러스터 간 연결을 확인하기 위해 하트비트 를 내보냅니다.

내부 하트비트 주제는 소스 클러스터에서 복제됩니다. 대상 클러스터는 하트비트 주제를 사용하여 다음을 확인합니다.

- 클러스터 간 연결을 관리하는 커넥터가 실행 중입니다.

- 소스 클러스터를 사용할 수 있음

2.4.2. 커넥터 구성

Kafka 클러스터 간 데이터 동기화를 오케스트레이션하는 내부 커넥터에 대한 Mirrormaker 2 커넥터 구성을 사용합니다.

다음 표에서는 커넥터 속성과 이를 사용하도록 구성하는 커넥터에 대해 설명합니다.

| 속성 | sourceConnector | checkpointConnector | heartbeatConnector |

|---|---|---|---|

| ✓ | ✓ | ✓ |

| ✓ | ✓ | ✓ |

| ✓ | ✓ | ✓ |

| ✓ | ✓ | |

| ✓ | ✓ | |

| ✓ | ✓ | |

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ | ||

| ✓ |

2.4.3. 커넥터 생산자 및 소비자 구성

MirrorMaker 2 커넥터는 내부 생산자와 소비자를 사용합니다. 필요한 경우 이러한 생산자와 소비자를 구성하여 기본 설정을 재정의할 수 있습니다.

예를 들어 소스 프로듀서의 batch.size 를 늘리고 대상 Kafka 클러스터에 주제를 보내 대량의 메시지를 더 잘 수용할 수 있습니다.

생산자 및 소비자 구성 옵션은 MirrorMaker 2 구현에 따라 달라지며 변경될 수 있습니다.

다음 표에는 각 커넥터의 생산자와 소비자와 구성을 추가할 수 있는 위치에 대해 설명합니다.

| 유형 | 설명 | 설정 |

|---|---|---|

| 프로듀서 | 주제 메시지를 대상 Kafka 클러스터로 보냅니다. 대량의 데이터를 처리할 때 이 생산자의 구성을 튜닝하는 것이 좋습니다. |

|

| 프로듀서 |

복제된 주제 파티션에 대한 소스 및 대상 오프셋을 매핑하는 |

|

| 소비자 | 소스 Kafka 클러스터에서 주제 메시지를 검색합니다. |

|

| 유형 | 설명 | 설정 |

|---|---|---|

| 프로듀서 | 소비자 오프셋 체크포인트를 내보냅니다. |

|

| 소비자 |

|

|

offset-syncs.topic.location 을 target 으로 설정하여 대상 Kafka 클러스터를 offset-syncs 주제의 위치로 사용할 수 있습니다.

| 유형 | 설명 | 설정 |

|---|---|---|

| 프로듀서 | 하트비트를 내보냅니다. |

|

다음 예제에서는 생산자 및 소비자를 구성하는 방법을 보여줍니다.

커넥터 생산자 및 소비자 구성의 예

2.4.4. 최대 작업 수 지정

Connectors는 Kafka 내부 및 외부에서 데이터를 이동하는 작업을 생성합니다. 각 커넥터는 작업을 실행하는 작업자 Pod 그룹에 분산된 하나 이상의 작업으로 구성됩니다. 많은 수의 파티션을 복제하거나 많은 수의 소비자 그룹의 오프셋을 동기화할 때 작업 수를 늘리면 성능 문제가 발생할 수 있습니다.Increase the number of tasks can help with performance issues when replicating a large number of partitions or synchronizing the offsets of a large number of consumer groups.

작업은 병렬로 실행됩니다. 작업자에는 하나 이상의 작업이 할당됩니다. 단일 작업은 하나의 작업자 Pod에서 처리하므로 작업보다 더 많은 작업자 Pod가 필요하지 않습니다. 작업자보다 많은 작업이 있는 경우 작업자는 여러 작업을 처리합니다.

tasksMax 속성을 사용하여 MirrorMaker 구성에서 최대 커넥터 작업 수를 지정할 수 있습니다. 최대 작업 수를 지정하지 않으면 기본 설정은 단일 작업입니다.

하트비트 커넥터는 항상 단일 작업을 사용합니다.

소스 및 체크포인트 커넥터에 대해 시작된 작업 수는 가능한 최대 작업 수와 tasksMax 의 값 사이에서 더 낮은 값입니다. 소스 커넥터의 경우 가능한 최대 작업 수는 소스 클러스터에서 복제되는 각 파티션에 대해 하나씩입니다. 체크포인트 커넥터의 경우 가능한 최대 작업 수는 소스 클러스터에서 복제되는 각 소비자 그룹마다 하나씩입니다. 최대 작업 수를 설정하는 경우 프로세스를 지원하는 파티션 수와 하드웨어 리소스를 고려하십시오.

인프라에서 처리 오버헤드를 지원하는 경우 작업 수를 늘리면 처리량과 대기 시간이 향상될 수 있습니다. 예를 들어 작업을 추가하면 많은 파티션 또는 소비자 그룹이 있는 경우 소스 클러스터를 폴링하는 데 걸리는 시간이 줄어듭니다.

검사점 커넥터에 대한 작업 수를 늘리면 파티션 수가 많으면 유용합니다.Increase the number of tasks for the checkpoint connector is useful when you have a large number of partitions.

소스 커넥터의 작업 수 늘리기

검사점 커넥터에 대한 작업 수를 늘리면 많은 수의 소비자 그룹이 있을 때 유용합니다.Increase the number of tasks for the checkpoint connector is useful when you have a large number of consumer groups.

체크포인트 커넥터에 대한 작업 수 늘리기

기본적으로 MirrorMaker 2는 10분마다 새 소비자 그룹을 확인합니다. refresh.groups.interval.seconds 구성을 조정하여 빈도를 변경할 수 있습니다. 더 낮게 조정할 때 주의하십시오. 더 자주 검사하면 성능에 부정적인 영향을 미칠 수 있습니다.

2.4.4.1. 커넥터 작업 확인

Prometheus 및 Grafana를 사용하여 배포를 모니터링하는 경우 MirrorMaker 2 성능을 확인할 수 있습니다. AMQ Streams와 함께 제공되는 MirrorMaker 2 Grafana 대시보드 예제에서는 작업 및 대기 시간과 관련된 다음 메트릭을 보여줍니다.

- 작업 수

- 복제 대기 시간

- 동기화 대기 시간 오프셋

2.4.5. ACL 규칙 동기화

User Operator를 사용하지 않는 경우 원격 항목에 대한 ACL 액세스가 가능합니다.

User Operator 없이 AclAuthorizer 를 사용하는 경우 브로커에 대한 액세스를 관리하는 ACL 규칙도 원격 항목에 적용됩니다. 소스 주제를 읽을 수 있는 사용자는 동등한 원격을 읽을 수 있습니다.

OAuth 2.0 권한 부여는 이러한 방식으로 원격 항목에 대한 액세스를 지원하지 않습니다.

2.4.6. Kafka MirrorMaker 2 구성

KafkaMirrorMaker2 리소스의 속성을 사용하여 Kafka MirrorMaker 2 배포를 구성합니다. MirrorMaker 2를 사용하여 Kafka 클러스터 간 데이터를 동기화합니다.

구성은 다음을 지정해야 합니다.

- 각 Kafka 클러스터

- 인증을 포함한 각 클러스터에 대한 연결 정보

복제 흐름 및 방향

- 클러스터로

- 주제 관련 주제

MirrorMaker의 이전 버전이 계속 지원됩니다. 이전 버전에 대해 구성된 리소스를 사용하려면 MirrorMaker 2에서 지원하는 형식으로 업데이트해야 합니다.

MirrorMaker 2는 복제 요소와 같은 속성에 대한 기본 구성 값을 제공합니다. 기본값이 변경되지 않은 최소 구성은 다음 예와 같습니다.

MirrorMaker 2에 대한 최소 구성

mTLS 또는 SASL 인증을 사용하여 소스 및 대상 클러스터에 대한 액세스 제어를 구성할 수 있습니다. 다음 절차에서는 소스 및 대상 클러스터에 TLS 암호화 및 mTLS 인증을 사용하는 구성을 보여줍니다.

KafkaMirrorMaker2 리소스의 소스 클러스터에서 복제할 주제 및 소비자 그룹을 지정할 수 있습니다. topicsPattern 및 groupsPattern 속성을 사용하여 이 작업을 수행합니다. 이름 목록을 제공하거나 정규식을 사용할 수 있습니다. 기본적으로 topicsPattern 및 groupsPattern 속성을 설정하지 않으면 모든 주제 및 소비자 그룹이 복제됩니다. 정규식으로 ".*" 를 사용하여 모든 주제와 소비자 그룹을 복제할 수도 있습니다. 그러나 클러스터에서 불필요한 추가 부하가 발생하지 않도록 하는 데 필요한 주제와 소비자 그룹만 지정하십시오.

대량의 메시지 처리

대량의 메시지를 처리하도록 구성을 조정할 수 있습니다. 자세한 내용은 대량 의 메시지 처리를 참조하십시오.

사전 요구 사항

- AMQ Streams가 실행 중

- 소스 및 대상 Kafka 클러스터 사용 가능

절차

KafkaMirrorMaker2리소스의spec속성을 편집합니다.구성할 수 있는 속성은 다음 예제 구성에 표시되어 있습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Kafka Connect 및 Mirror 2.0 버전 2.0은 항상 동일합니다.

- 2

- 작업을 실행하는 작업자 의 복제본 노드 수입니다.

- 3

- Kafka Connect의 Kafka 클러스터 별칭 - 대상 Kafka 클러스터를 지정해야 합니다. Kafka 클러스터는 내부 항목에 대해 Kafka Connect에서 사용합니다.

- 4

- 동기화되는 Kafka 클러스터의 사양 입니다.

- 5

- 소스 Kafka 클러스터의 클러스터 별칭 입니다.

- 6

- 7

- 소스 Kafka 클러스터에 연결하기 위한 부트스트랩 서버 입니다.

- 8

- 소스 Kafka 클러스터의 X.509 형식으로 저장되는 TLS 인증서의 키 이름을 사용한 TLS 암호화 입니다. 인증서가 동일한 보안에 저장된 경우 여러 번 나열할 수 있습니다.

- 9

- 대상 Kafka 클러스터의 클러스터 별칭 입니다.

- 10

- 대상 Kafka 클러스터에 대한 인증은 소스 Kafka 클러스터와 동일한 방식으로 구성됩니다.

- 11

- 대상 Kafka 클러스터에 연결하기 위한 부트스트랩 서버 입니다.

- 12

- Kafka Connect 구성. 표준 Apache Kafka 구성을 제공하여 AMQ Streams에서 직접 관리하지 않는 속성으로 제한될 수 있습니다.

- 13

- 외부 리스너가 TLS 버전에 대한 특정 암호화 제품군으로 실행되도록 하는 SSL 속성입니다.

- 14

HTTPS로 설정하여 호스트 이름 확인이 활성화됩니다. 빈 문자열은 확인을 비활성화합니다.- 15

- 대상 Kafka 클러스터에 대한 TLS 암호화는 소스 Kafka 클러스터와 동일한 방식으로 구성됩니다.

- 16

- 17

- MirrorMaker 2 커넥터에서 사용하는 소스 클러스터의 클러스터 별칭 입니다.

- 18

- MirrorMaker 2 커넥터에서 사용하는 대상 클러스터의 클러스터 별칭 입니다.

- 19

- 원격 주제를 생성하는

MirrorSourceConnector구성입니다. 구성이 기본 구성 옵션을 덮어씁니다. - 20

- 커넥터가 생성할 수 있는 최대 작업 수입니다. 작업은 데이터 복제를 처리하고 병렬로 실행합니다. 인프라에서 처리 오버헤드를 지원하는 경우 이 값을 늘리면 처리량이 향상될 수 있습니다. Kafka Connect는 클러스터 멤버 간에 작업을 배포합니다. 작업자보다 많은 작업이 있는 경우 작업자에는 여러 작업이 할당됩니다. 싱크 커넥터의 경우 소비된 각 주제 파티션에 대해 하나의 작업이 있어야 합니다. 소스 커넥터의 경우 병렬로 실행할 수 있는 작업 수도 외부 시스템에 따라 달라질 수 있습니다. 커넥터는 병렬 처리를 수행할 수 없는 경우 최대 작업 수보다 적은 수를 생성합니다.

- 21

- 실패한 커넥터 및 작업의 자동 재시작을 활성화합니다. 재시작 횟수는 최대 7개까지 수행되며, 이 후에는 수동으로 다시 시작해야 합니다.

- 22

- 대상 클러스터에서 생성된 미러링된 항목의 복제 요인입니다.

- 23

- 소스 및 대상 클러스터

의 오프셋을매핑하는MirrorSourceConnector오프셋의 복제 요인입니다. - 24

- ACL 규칙 동기화 가 활성화되면 ACL이 동기화된 항목에 적용됩니다. 기본값은

true입니다. 이 기능은 User Operator와 호환되지 않습니다. User Operator를 사용하는 경우 이 속성을false로 설정합니다. - 25

- 새 항목에 대한 검사 빈도를 변경하는 선택적 설정입니다. 기본값은 10분마다 점검을 위한 것입니다.

- 26

- 원격 주제 이름 변경에 사용되는 구분자를 정의합니다.

- 27

- 원격 주제의 자동 이름 변경을 재정의하는 정책을 추가합니다. 소스 클러스터 이름 앞에 이름 앞에 추가하지 않고 주제에서 원래 이름을 유지합니다. 이 선택적 설정은 활성/수동 백업 및 데이터 마이그레이션에 유용합니다. 주제 오프셋 동기화를 구성하려면 이 속성도

checkpointConnector.config에 대해 설정해야 합니다. - 28

- 연결 확인을 수행하는

MirrorHeartbeatConnector구성입니다. 구성이 기본 구성 옵션을 덮어씁니다. - 29

- 대상 클러스터에서 생성된 하트비트 항목에 대한 복제 요인입니다.

- 30

- 오프셋을 추적하는

MirrorCheckpointConnector구성입니다. 구성이 기본 구성 옵션을 덮어씁니다. - 31

- 대상 클러스터에서 생성된 체크포인트 항목에 대한 복제 요인입니다.

- 32

- 새 소비자 그룹에 대한 검사 빈도를 변경하는 선택적 설정입니다. 기본값은 10분마다 점검을 위한 것입니다.

- 33

- 활성/수동 구성에서 복구에 유용한 소비자 그룹 오프셋을 동기화하는 선택적 설정입니다. 동기화는 기본적으로 활성화되어 있지 않습니다.

- 34

- 소비자 그룹 오프셋의 동기화가 활성화된 경우 동기화 빈도를 조정할 수 있습니다.

- 35

- 오프셋 추적에 대한 검사 빈도를 조정합니다. 오프셋 동기화의 빈도를 변경하는 경우 이러한 검사의 빈도를 조정해야 할 수도 있습니다.

- 36

- 쉼표로 구분된 목록 또는 정규식 패턴으로 정의된 소스 클러스터의 주제 복제 주제 복제 . 소스 커넥터는 지정된 주제를 복제합니다. 검사점 커넥터는 지정된 항목에 대한 오프셋을 추적합니다. 여기에서는 이름으로 세 가지 주제를 요청합니다.

- 37

- 쉼표로 구분된 목록 또는 정규식 패턴으로 정의된 소스 클러스터의 소비자 그룹 복제입니다. 검사점 커넥터는 지정된 소비자 그룹을 복제합니다. 여기에서는 이름별로 세 개의 소비자 그룹을 요청합니다.

- 38

- 39

- 지정된 Kafka Connect 로거 및 로그 수준은 ConfigMap을 통해 직접 (

인라인) 또는 간접적으로(외부)합니다. 사용자 지정 ConfigMap은log4j.properties또는log4j2.properties키에 배치해야 합니다. Kafka Connectlog4j.rootLogger로거의 경우 로그 수준을 INFO, ERROR, WARN, TRACE, DEBUG, FATAL 또는 OFF로 설정할 수 있습니다. - 40

- 컨테이너(liveness)를 다시 시작할 시기와 컨테이너가 트래픽을 수락할 수 있는 시기(가용성)를 확인할 수 있는 상태 점검 입니다.

- 41

- Kafka Mirror Maker를 실행하는 VM(가상 머신)의 성능을 최적화하는 JVM 구성 옵션입니다.

- 42

- ADVANCED OPTION : 컨테이너 이미지 구성.이는 특별한 경우에만 권장됩니다.

- 43

- SPECIALIZED OPTION: 배포에 대한 인식 인식 구성입니다. 이는 리전이 아닌 동일한 위치 내의 배포를 위한 특수 옵션입니다. 리더 복제본이 아닌 가장 가까운 복제본에서 커넥터를 소비하려면 이 옵션을 사용합니다. 경우에 따라 가장 가까운 복제본에서 소비하면 네트워크 사용률을 향상시키거나 비용을 줄일 수 있습니다.

topologyKey는 rack ID가 포함된 노드 레이블과 일치해야 합니다. 이 구성에 사용된 예제에서는 표준topology.kubernetes.io/zone레이블을 사용하여 영역을 지정합니다. 가장 가까운 복제본에서 사용하려면 Kafka 브로커 구성에서RackAwareReplicaSelector를 활성화합니다. - 44

- 템플릿 사용자 지정. 여기에서 Pod는 유사성 방지로 예약되므로 Pod는 동일한 호스트 이름이 있는 노드에 예약되지 않습니다.

- 45

- 환경 변수는 분산 추적을 위해 설정됩니다.

- 46

- Jaeger에 대해 분산 추적이 활성화됩니다.

- 47

- Kafka MirrorMaker에 환경 변수로 마운트된 OpenShift Secret의 외부 구성 구성 공급자 플러그인 을 사용하여 외부 소스에서 구성 값을 로드할 수도 있습니다.

리소스를 생성하거나 업데이트합니다.

oc apply -f MIRRORMAKER-CONFIGURATION-FILE

oc apply -f MIRRORMAKER-CONFIGURATION-FILECopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.7. Kafka MirrorMaker 2 배포 보안

이 절차에서는 MirrorMaker 2 배포를 보호하는 데 필요한 구성을 간략하게 설명합니다.

소스 Kafka 클러스터 및 대상 Kafka 클러스터에 대한 별도의 구성이 필요합니다. 또한 소스 및 대상 Kafka 클러스터에 연결하는 데 필요한 인증 정보를 제공하기 위해 별도의 사용자 구성이 필요합니다.

Kafka 클러스터의 경우 OpenShift 클러스터 외부의 연결에 대해 OpenShift 클러스터 및 외부 리스너 내 보안 연결을 위해 내부 리스너를 지정합니다.

인증 및 권한 부여 메커니즘을 구성할 수 있습니다. 소스 및 대상 Kafka 클러스터에 대해 구현된 보안 옵션은 MirrorMaker 2에 대해 구현된 보안 옵션과 호환되어야 합니다.

클러스터 및 사용자 인증 자격 증명을 생성한 후 보안 연결을 위해 MirrorMaker 구성에 지정합니다.

이 절차에서는 Cluster Operator에서 생성한 인증서가 사용되지만 자체 인증서를 설치하여 교체할 수 있습니다. 외부 CA(인증 기관)에서 관리하는 Kafka 리스너 인증서를 사용하도록 리스너를 구성할 수도 있습니다.

시작하기 전에

이 절차를 시작하기 전에 AMQ Streams에서 제공하는 구성 파일 예제 를 살펴보십시오. 여기에는 mTLS 또는 SCRAM-SHA-512 인증을 사용하여 MirrorMaker 2 배포를 보호하는 예제가 포함됩니다. 예제에서는 OpenShift 클러스터 내에서 연결하기 위한 내부 리스너를 지정합니다.

예제에서는 소스 및 대상 Kafka 클러스터에서 작업을 허용하는 MirrorMaker 2에 필요한 모든 ACL을 포함하여 전체 승인을 위한 구성을 제공합니다.

사전 요구 사항

- AMQ Streams가 실행 중

- 소스 및 대상 클러스터의 별도의 네임스페이스

이 절차에서는 Topic Operator를 사용하려면 소스 및 대상 Kafka 클러스터가 별도의 네임스페이스에 설치되어 있다고 가정합니다. Topic Operator는 지정된 네임스페이스에서 단일 클러스터만 감시합니다.

클러스터를 네임스페이스로 분리하면 네임스페이스 외부에서 액세스할 수 있도록 클러스터 시크릿을 복사해야 합니다. MirrorMaker 구성에서 시크릿을 참조해야 합니다.

절차

두 개의

Kafka리소스를 구성합니다. 하나는 소스 Kafka 클러스터를 보호하고 하나는 대상 Kafka 클러스터를 보호합니다.인증을 위한 리스너 구성을 추가하고 권한 부여를 활성화할 수 있습니다.

이 예에서 내부 리스너는 TLS 암호화 및 mTLS 인증을 사용하는 Kafka 클러스터에 대해 구성됩니다. Kafka

간단한인증이 활성화됩니다.TLS 암호화 및 mTLS 인증을 사용하는 소스 Kafka 클러스터 구성의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow TLS 암호화 및 mTLS 인증을 사용하는 대상 Kafka 클러스터 구성의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 별도의 네임스페이스에서

Kafka리소스를 생성하거나 업데이트합니다.oc apply -f <kafka_configuration_file> -n <namespace>

oc apply -f <kafka_configuration_file> -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Cluster Operator는 리스너를 생성하고 클러스터 및 클라이언트 CA(인증 기관) 인증서를 설정하여 Kafka 클러스터 내에서 인증을 활성화합니다.

인증서는 <

cluster_name> -cluster-ca-cert에서 생성됩니다.소스 Kafka 클러스터의 사용자 및 대상 Kafka 클러스터의 사용자용으로 하나씩 두 개의

KafkaUser리소스를 구성합니다.-

해당 소스 및 대상 Kafka 클러스터와 동일한 인증 및 권한 부여 유형을 구성합니다. 예를 들어 소스 Kafka 클러스터의

Kafka구성에서tls인증 및간단한권한 부여 유형을 사용한 경우KafkaUser구성에서 동일하게 사용합니다. 소스 및 대상 Kafka 클러스터에서 작업을 허용하도록 MirrorMaker 2에 필요한 ACL을 구성합니다.

ACL은 내부 MirrorMaker 커넥터와 기본 Kafka Connect 프레임워크에서 사용합니다.

mTLS 인증에 대한 소스 사용자 구성 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow mTLS 인증에 대한 대상 사용자 구성 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고type을tls-external로 설정하여 User Operator 외부에서 발급한 인증서를 사용할 수 있습니다. 자세한 내용은 6.2.93절. “KafkaUserSpecschema reference”의 내용을 참조하십시오.-

해당 소스 및 대상 Kafka 클러스터와 동일한 인증 및 권한 부여 유형을 구성합니다. 예를 들어 소스 Kafka 클러스터의

소스 및 대상 Kafka 클러스터에 대해 생성한 각 네임스페이스에서

KafkaUser리소스를 생성하거나 업데이트합니다.oc apply -f <kafka_user_configuration_file> -n <namespace>

oc apply -f <kafka_user_configuration_file> -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow User Operator는 선택한 인증 유형을 기반으로 클라이언트(MirrorMaker)와 클라이언트 인증에 사용되는 보안 인증 정보를 나타내는 사용자를 생성합니다.

User Operator는

KafkaUser리소스와 동일한 이름으로 새 시크릿을 생성합니다. 보안에는 mTLS 인증을 위한 개인 키와 공개 키가 포함되어 있습니다. 공개 키는 클라이언트 CA에서 서명한 사용자 인증서에 포함됩니다.인증 세부 정보를 사용하여

KafkaMirrorMaker2리소스를 구성하여 소스 및 대상 Kafka 클러스터에 연결합니다.TLS 암호화 및 mTLS 인증을 사용하는 MirrorMaker 2 구성의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 대상 Kafka 클러스터와 동일한 네임스페이스에서

KafkaMirrorMaker2리소스를 생성하거나 업데이트합니다.oc apply -f <mirrormaker2_configuration_file> -n <namespace_of_target_cluster>

oc apply -f <mirrormaker2_configuration_file> -n <namespace_of_target_cluster>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.8. Kafka MirrorMaker 2 커넥터 다시 시작 수행

다음 절차에서는 OpenShift 주석을 사용하여 Kafka MirrorMaker 2 커넥터의 재시작을 수동으로 트리거하는 방법을 설명합니다.

사전 요구 사항

- Cluster Operator가 실행 중입니다.

절차

다시 시작하려는

Kafka MirrorMaker 2커넥터를 제어하는 KafkaMirrorMaker2 사용자 정의 리소스의 이름을 찾습니다.oc get KafkaMirrorMaker2

oc get KafkaMirrorMaker2Copy to Clipboard Copied! Toggle word wrap Toggle overflow KafkaMirrorMaker2 사용자 정의 리소스에서 다시 시작할

Kafka MirrorMaker 2커넥터의 이름을 찾습니다.oc describe KafkaMirrorMaker2 KAFKAMIRRORMAKER-2-NAME

oc describe KafkaMirrorMaker2 KAFKAMIRRORMAKER-2-NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 커넥터를 다시 시작하려면 OpenShift에서

KafkaMirrorMaker2리소스에 주석을 답니다. 이 예에서oc annotate는my-source->my-target.MirrorSourceConnector라는 커넥터를 다시 시작합니다.oc annotate KafkaMirrorMaker2 KAFKAMIRRORMAKER-2-NAME "strimzi.io/restart-connector=my-source->my-target.MirrorSourceConnector"

oc annotate KafkaMirrorMaker2 KAFKAMIRRORMAKER-2-NAME "strimzi.io/restart-connector=my-source->my-target.MirrorSourceConnector"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 조정이 수행될 때까지 기다립니다(기본적으로 2분 마다).

조정 프로세스에서 주석을 탐지한 한 Kafka MirrorMaker 2 커넥터가 재시작됩니다. 재시작 요청이 승인되면

KafkaMirrorMaker2사용자 정의 리소스에서 주석이 제거됩니다.

2.4.9. Kafka MirrorMaker 2 커넥터 작업 재시작 수행

다음 절차에서는 OpenShift 주석을 사용하여 Kafka MirrorMaker 2 커넥터 작업 재시작을 수동으로 트리거하는 방법을 설명합니다.

사전 요구 사항

- Cluster Operator가 실행 중입니다.

절차

다시 시작하려는

Kafka MirrorMaker 2커넥터를 제어하는 KafkaMirrorMaker2 사용자 정의 리소스의 이름을 찾습니다.oc get KafkaMirrorMaker2

oc get KafkaMirrorMaker2Copy to Clipboard Copied! Toggle word wrap Toggle overflow Kafka MirrorMaker 2 커넥터의 이름과

KafkaMirrorMaker2사용자 정의 리소스에서 다시 시작할 작업의 ID를 찾습니다. 작업 ID는 0부터 시작하는 음수가 아닌 정수입니다.oc describe KafkaMirrorMaker2 KAFKAMIRRORMAKER-2-NAME

oc describe KafkaMirrorMaker2 KAFKAMIRRORMAKER-2-NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 커넥터 작업을 다시 시작하려면 OpenShift에서

KafkaMirrorMaker2리소스에 주석을 답니다. 이 예에서oc annotaterestarts 작업 0 of a connector namedmy-source->my-target.MirrorSourceConnector:oc annotate KafkaMirrorMaker2 KAFKAMIRRORMAKER-2-NAME "strimzi.io/restart-connector-task=my-source->my-target.MirrorSourceConnector:0"

oc annotate KafkaMirrorMaker2 KAFKAMIRRORMAKER-2-NAME "strimzi.io/restart-connector-task=my-source->my-target.MirrorSourceConnector:0"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 조정이 수행될 때까지 기다립니다(기본적으로 2분 마다).

조정 프로세스에서 주석을 탐지한 한 Kafka MirrorMaker 2 커넥터 작업이 재시작됩니다. 재시작 작업 요청이 수락되면 주석이

KafkaMirrorMaker2사용자 정의 리소스에서 제거됩니다.

2.5. Kafka MirrorMaker 클러스터 구성

KafkaMirrorMaker 리소스를 사용하여 Kafka MirrorMaker 배포를 구성합니다. KafkaMirrorMaker는 Kafka 클러스터 간에 데이터를 복제합니다.

6.2.108절. “KafkaMirrorMaker 스키마 참조” KafkaMirrorMaker 리소스의 전체 스키마를 설명합니다.

AMQ Streams를 MirrorMaker 또는 MirrorMaker 2 와 함께 사용할 수 있습니다. MirrorMaker 2는 최신 버전이며 Kafka 클러스터 간 데이터를 더 효율적으로 미러링할 수 있는 방법을 제공합니다.

Kafka MirrorMaker 1(문서의 MirrorMaker 라고도 함)은 Apache Kafka 3.0.0에서 더 이상 사용되지 않으며 Apache Kafka 4.0.0에서 제거됩니다. 결과적으로 Kafka MirrorMaker 1을 배포하는 데 사용되는 KafkaMirrorMaker 사용자 정의 리소스도 AMQ Streams에서 더 이상 사용되지 않습니다. Apache Kafka 4.0.0을 채택하면 KafkaMirrorMaker 리소스가 AMQ Streams에서 제거됩니다. 대체 방법으로 KafkaMirrorMaker2 사용자 정의 리소스를 IdentityReplicationPolicy 와 함께 사용합니다.

2.5.1. Kafka MirrorMaker 구성

KafkaMirrorMaker 리소스의 속성을 사용하여 Kafka MirrorMaker 배포를 구성합니다.

TLS 또는 SASL 인증을 사용하여 생산자 및 소비자에 대한 액세스 제어를 구성할 수 있습니다. 다음 절차에서는 소비자 및 생산자 측에서 TLS 암호화 및 mTLS 인증을 사용하는 구성을 보여줍니다.

사전 요구 사항

다음을 실행하는 방법에 대한 자세한 내용은 OpenShift에 AMQ Streams 배포 및 업그레이드 가이드를 참조하십시오.

- 소스 및 대상 Kafka 클러스터 사용 가능

절차

KafkaMirrorMaker리소스의spec속성을 편집합니다.구성할 수 있는 속성은 다음 예제 구성에 표시되어 있습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 2

- 소비자 및 생산자용 부트스트랩 서버 입니다.

- 3

- 4

- 5

- 6

- 소비자 또는 생산자의 X.509 형식으로 저장되는 TLS 인증서의 키 이름이 포함된 TLS 암호화 입니다. 인증서가 동일한 보안에 저장된 경우 여러 번 나열할 수 있습니다.

- 7

- 8

- 9

- 외부 리스너가 TLS 버전에 대한 특정 암호화 제품군으로 실행되도록 하는 SSL 속성입니다.

- 10

HTTPS로 설정하여 호스트 이름 확인이 활성화됩니다. 빈 문자열은 확인을 비활성화합니다.- 11

abortOnSendFailure속성이true로 설정되면 Kafka MirrorMaker가 종료되고 메시지에 대한 전송 실패 후에 컨테이너가 다시 시작됩니다.- 12

- 외부 리스너가 TLS 버전에 대한 특정 암호화 제품군으로 실행되도록 하는 SSL 속성입니다.

- 13

HTTPS로 설정하여 호스트 이름 확인이 활성화됩니다. 빈 문자열은 확인을 비활성화합니다.- 14

- 소스에서 대상 Kafka 클러스터로 미러링된 포함된 주제입니다.

- 15

- 16

- 지정된 로거 및 로그 수준이 직접 (

인라인) 추가되거나 ConfigMap을 통해 간접적으로(외부)합니다. 사용자 지정 ConfigMap은log4j.properties또는log4j2.properties키에 배치해야 합니다. MirrorMaker에는mirrormaker.root.logger라는 단일 로거가 있습니다. 로그 수준을 INFO, ERROR, WARN, TRACE, DEBUG, FATAL 또는 OFF로 설정할 수 있습니다. - 17

- 컨테이너(liveness)를 다시 시작할 시기와 컨테이너가 트래픽을 수락할 수 있는 시기(가용성)를 확인할 수 있는 상태 점검 입니다.

- 18

- Prometheus 지표: 이 예제에서 Prometheus exporter에 대한 구성이 포함된 ConfigMap을 참조하여 활성화합니다.

metricsConfig.valueFrom.configMapKeyRef.key아래에 빈 파일이 포함된 ConfigMap에 대한 참조를 사용하여 추가 구성 없이 메트릭을 활성화할 수 있습니다. - 19

- Kafka Mirror Maker를 실행하는 VM(가상 머신)의 성능을 최적화하는 JVM 구성 옵션입니다.

- 20

- ADVANCED OPTION : 컨테이너 이미지 구성.이는 특별한 경우에만 권장됩니다.

- 21

- 템플릿 사용자 지정. 여기에서 Pod는 유사성 방지로 예약되므로 Pod는 동일한 호스트 이름이 있는 노드에 예약되지 않습니다.

- 22

- 환경 변수는 분산 추적을 위해 설정됩니다.

- 23

- Jaeger에 대해 분산 추적이 활성화됩니다.

주의abortOnSendFailure속성을false로 설정하면 생산자가 주제의 다음 메시지를 보냅니다. 실패 메시지를 다시 전송하려는 시도가 없기 때문에 원본 메시지가 손실될 수 있습니다.리소스를 생성하거나 업데이트합니다.

oc apply -f <your-file>

oc apply -f <your-file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.2. Kafka MirrorMaker 클러스터 리소스 목록

다음 리소스는 OpenShift 클러스터의 Cluster Operator에 의해 생성됩니다.

- <mirror-maker-name>-mirror-maker

- Kafka MirrorMaker 포드 생성을 담당하는 배포입니다.

- <mirror-maker-name>-config

- Kafka MirrorMaker에 대한 보조 구성을 포함하고 Kafka 브로커 Pod에서 볼륨으로 마운트되는 ConfigMap입니다.

- <mirror-maker-name>-mirror-maker

- Kafka MirrorMaker 작업자 노드에 대해 구성된 Pod 중단 예산입니다.

2.6. Kafka 브리지 클러스터 구성

KafkaBridge 리소스를 사용하여 Kafka 브리지 배포를 구성합니다. Kafka 브리지는 HTTP 기반 클라이언트를 Kafka 클러스터와 통합하는 API를 제공합니다.

6.2.114절. “KafkaBridge 스키마 참조” KafkaBridge 리소스의 전체 스키마를 설명합니다.

2.6.1. Kafka 브리지 구성

Kafka 브리지를 사용하여 Kafka 클러스터에 대한 HTTP 기반 요청을 수행합니다.

KafkaBridge 리소스의 속성을 사용하여 Kafka Bridge 배포를 구성합니다.

클라이언트 소비자 요청이 다른 Kafka Bridge 인스턴스에서 처리할 때 발생하는 문제를 방지하려면 올바른 Kafka 브리지 인스턴스로 요청이 라우팅되도록 주소 기반 라우팅을 사용해야 합니다. 또한 각 독립 Kafka 브리지 인스턴스에는 복제본이 있어야 합니다. Kafka 브리지 인스턴스에는 다른 인스턴스와 공유되지 않는 자체 상태가 있습니다.

사전 요구 사항

- OpenShift 클러스터

- 실행 중인 Cluster Operator

다음을 실행하는 방법에 대한 자세한 내용은 OpenShift에 AMQ Streams 배포 및 업그레이드 가이드를 참조하십시오.

절차

KafkaBridge리소스의spec속성을 편집합니다.구성할 수 있는 속성은 다음 예제 구성에 표시되어 있습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 2

- 대상 Kafka 클러스터에 연결하기 위한 부트스트랩 서버 입니다. Kafka 클러스터의 이름을 < cluster_name>으로 사용합니다.

- 3

- 소스 Kafka 클러스터의 X.509 형식으로 저장되는 TLS 인증서의 키 이름을 사용한 TLS 암호화 입니다. 인증서가 동일한 보안에 저장된 경우 여러 번 나열할 수 있습니다.

- 4

- mTLS,토큰 기반 OAuth, SASL 기반 SCRAM -256/SCRAM-SHA -512, 또는 PLAIN 으로 지정된 Kafka Bridge 클러스터에 대한 인증입니다. 기본적으로 Kafka 브리지는 인증 없이 Kafka 브로커에 연결합니다.

- 5

- Kafka 브로커에 대한 HTTP 액세스

- 6

- CORS 액세스는 선택한 리소스 및 액세스 방법을 지정합니다. 요청의 추가 HTTP 헤더는 Kafka 클러스터에 액세스할 수 있는 출처를 설명합니다.

- 7

- 소비자 구성 옵션.

- 8

- 생산자 구성 옵션.

- 9

- 10

- 지정된 Kafka Bridge 로거 및 로그 수준이 ConfigMap을 통해 직접(

인라인) 또는 간접적으로(외부)합니다. 사용자 지정 ConfigMap은log4j.properties또는log4j2.properties키에 배치해야 합니다. Kafka 브리지 로거의 경우 로그 수준을 INFO, ERROR, WARN, TRACE, DEBUG, FATAL 또는 OFF로 설정할 수 있습니다. - 11

- Kafka 브리지 를 실행하는 VM(가상 머신)의 성능을 최적화하는 JVM 구성 옵션입니다.

- 12

- 컨테이너(liveness)를 다시 시작할 시기와 컨테이너가 트래픽을 수락할 수 있는 시기(가용성)를 확인할 수 있는 상태 점검 입니다.

- 13

- 선택 사항 : 컨테이너 이미지 구성.이는 특별한 경우에만 권장됩니다.

- 14

- 템플릿 사용자 지정. 여기에서 Pod는 유사성 방지로 예약되므로 Pod는 동일한 호스트 이름이 있는 노드에 예약되지 않습니다.

- 15

- 환경 변수는 분산 추적을 위해 설정됩니다.

리소스를 생성하거나 업데이트합니다.

oc apply -f KAFKA-BRIDGE-CONFIG-FILE

oc apply -f KAFKA-BRIDGE-CONFIG-FILECopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6.2. Kafka 브리지 클러스터 리소스 목록

다음 리소스는 OpenShift 클러스터의 Cluster Operator에 의해 생성됩니다.

- bridge-cluster-name-bridge

- Kafka 브리지 작업자 노드 Pod를 생성하는 데 필요한 배포입니다.

- bridge-cluster-name-bridge-service

- Kafka 브리지 클러스터의 REST 인터페이스를 노출하는 서비스입니다.

- bridge-cluster-name-bridge-config

- Kafka 브리지 보조 구성이 포함되어 있고 Kafka 브로커 Pod에서 볼륨으로 마운트되는 ConfigMap입니다.

- bridge-cluster-name-bridge

- Kafka 브리지 작업자 노드에 대해 구성된 Pod 중단 예산.

2.7. OpenShift 리소스 사용자 정의

AMQ Streams 배포는 Deployments,StatefulSets,Pod 및 Services 와 같은 OpenShift 리소스를 생성합니다. 이러한 리소스는 AMQ Streams Operator에서 관리합니다. 특정 OpenShift 리소스 관리를 담당하는 Operator만 해당 리소스를 변경할 수 있습니다. Operator에서 관리하는 OpenShift 리소스를 수동으로 변경하려고 하면 Operator에서 변경 사항을 되돌립니다.

Operator 관리 OpenShift 리소스 변경은 다음과 같은 특정 작업을 수행하려는 경우 유용할 수 있습니다.

-

Istio 또는 기타 서비스에서

Pod를 처리하는 방법을 제어하는 사용자 정의 라벨 또는 주석 추가 -

클러스터에서

로드 밸런서-type 서비스를 생성하는 방법 관리

AMQ Streams 사용자 정의 리소스의 template 속성을 사용하여 변경할 수 있습니다. template 속성은 다음 리소스에서 지원됩니다. API 참조는 사용자 정의 필드에 대한 자세한 정보를 제공합니다.

Kafka.spec.kafka-

참조 6.2.33절. “

KafkaClusterTemplate스키마 참조” Kafka.spec.zookeeper-

참조 6.2.43절. “

ZookeeperClusterTemplate스키마 참조” Kafka.spec.entityOperator-

참조 6.2.48절. “

EntityOperatorTemplate스키마 참조” Kafka.spec.kafkaExporter-

참조 6.2.56절. “

KafkaExporterTemplate스키마 참조” Kafka.spec.cruiseControl-

참조 6.2.52절. “

CruiseControlTemplate스키마 참조” KafkaConnect.spec-

참조 6.2.72절. “

KafkaConnectTemplate스키마 참조” KafkaMirrorMaker.spec-

참조 6.2.112절. “

KafkaMirrorMakerTemplate스키마 참조” KafkaMirrorMaker2.spec-

참조 6.2.72절. “

KafkaConnectTemplate스키마 참조” KafkaBridge.spec-

참조 6.2.121절. “

KafkaBridgeTemplate스키마 참조” KafkaUser.spec-

참조 6.2.106절. “

KafkaUserTemplate스키마 참조”

다음 예제에서 template 속성은 Kafka 브로커의 Pod에서 라벨을 수정하는 데 사용됩니다.

템플릿 사용자 지정 예

2.7.1. 이미지 가져오기 정책 사용자 정의

AMQ Streams를 사용하면 Cluster Operator가 배포한 모든 Pod에서 컨테이너의 이미지 가져오기 정책을 사용자 지정할 수 있습니다. 이미지 가져오기 정책은 Cluster Operator 배포에서 환경 변수 STRIMZI_IMAGE_PULL_POLICY 를 사용하여 구성됩니다. STRIMZI_IMAGE_PULL_POLICY 환경 변수는 세 가지 다른 값으로 설정할 수 있습니다.

Always- 컨테이너 이미지는 포드를 시작하거나 다시 시작할 때마다 레지스트리에서 컨테이너 이미지를 가져옵니다.

IfNotPresent- 컨테이너 이미지는 이전에 가져오지 않은 경우에만 레지스트리에서 가져옵니다.

Never- 컨테이너 이미지는 레지스트리에서 가져오지 않습니다.

현재 이미지 풀 정책은 한 번에 모든 Kafka, Kafka Connect 및 Kafka MirrorMaker 클러스터에 대해서만 사용자 지정할 수 있습니다. 정책을 변경하면 모든 Kafka, Kafka Connect 및 Kafka MirrorMaker 클러스터의 롤링 업데이트가 생성됩니다.

2.7.2. 종료 유예 기간 적용

Kafka 클러스터를 종료할 충분한 시간을 제공하기 위해 종료 유예 기간을 적용합니다.

terminationGracePeriodSeconds 속성을 사용하여 시간을 지정합니다. Kafka 사용자 정의 리소스의 template.pod 구성에 속성을 추가합니다.

추가하는 시간은 Kafka 클러스터의 크기에 따라 달라집니다. 종료 유예 기간의 OpenShift 기본값은 30초입니다. 클러스터가 완전히 종료되지 않는 경우 종료 유예 기간을 늘릴 수 있습니다.

Pod를 다시 시작할 때마다 종료 유예 기간이 적용됩니다. 기간은 OpenShift가 포드에서 실행 중인 프로세스에 용어 (기화) 신호를 보낼 때 시작됩니다. 기간은 종료 Pod의 프로세스를 중지하기 전에 다른 Pod로 전송하는 데 필요한 시간을 반영해야 합니다. 기간이 종료되면 종료 신호는 Pod에서 계속 실행 중인 모든 프로세스를 중지합니다.

다음 예제에서는 Kafka 사용자 정의 리소스에 120초의 종료 유예 기간을 추가합니다. 다른 Kafka 구성 요소의 사용자 정의 리소스에 구성을 지정할 수도 있습니다.

종료 유예 구성의 예

2.8. Pod 예약 구성

두 애플리케이션이 동일한 OpenShift 노드에 예약되면 두 애플리케이션 모두 디스크 I/O와 동일한 리소스를 사용하고 성능에 영향을 줄 수 있습니다. 이로 인해 성능이 저하될 수 있습니다. 다른 중요한 워크로드와 노드 공유를 방지할 수 있는 방식으로 Kafka Pod를 예약하거나, 올바른 노드를 사용하거나 Kafka에만 전용 노드 세트는 이러한 문제를 방지하는 가장 좋은 방법입니다.

2.8.1. 선호도, 허용 오차 및 토폴로지 분배 제약 조건 지정

유사성, 허용 오차 및 토폴로지 분배 제약 조건을 사용하여 kafka 리소스의 Pod를 노드에 예약합니다. 유사성, 허용 오차 및 토폴로지 분배 제약 조건은 다음 리소스에서 선호도,허용 오차 및 topologySpreadConstraint 속성을 사용하여 구성됩니다.

-

Kafka.spec.kafka.template.pod -

Kafka.spec.zookeeper.template.pod -

Kafka.spec.entityOperator.template.pod -

KafkaConnect.spec.template.pod -

KafkaBridge.spec.template.pod -

KafkaMirrorMaker.spec.template.pod -

KafkaMirrorMaker2.spec.template.pod

선호도,tolerations, topologySpreadConstraint 속성의 형식은 OpenShift 사양을 따릅니다. 선호도 구성에는 다양한 유형의 선호도가 포함될 수 있습니다.

- Pod 유사성 및 유사성 방지

- 노드 유사성

2.8.1.1. Pod 유사성 방지를 사용하여 중요한 애플리케이션 공유 노드 방지

Pod 유사성 방지를 사용하여 중요한 애플리케이션이 동일한 디스크에 예약되지 않도록 합니다. Kafka 클러스터를 실행할 때 Pod 유사성 방지를 사용하여 Kafka 브로커가 데이터베이스와 같은 다른 워크로드와 노드를 공유하지 않도록 하는 것이 좋습니다.

2.8.1.2. 노드 선호도를 사용하여 특정 노드에 워크로드를 예약

OpenShift 클러스터는 일반적으로 다양한 유형의 작업자 노드로 구성됩니다. 일부는 CPU 사용량이 많은 워크로드, 메모리용으로 최적화되고 다른 일부는 스토리지(빠른 로컬 SSD) 또는 네트워크에 최적화될 수 있습니다. 다른 노드를 사용하면 비용과 성능을 모두 최적화하는 데 도움이 됩니다. 가능한 최상의 성능을 얻으려면 AMQ Streams 구성 요소를 올바른 노드를 사용하도록 예약하는 것이 중요합니다.

OpenShift는 노드 선호도를 사용하여 특정 노드에 워크로드를 예약합니다. 노드 유사성을 사용하면 Pod를 예약할 노드에 대한 예약 제약 조건을 생성할 수 있습니다. 제약 조건은 라벨 선택기로 지정됩니다. beta.kubernetes.io/instance-type 과 같은 기본 제공 노드 레이블을 사용하여 레이블을 지정하여 올바른 노드를 선택할 수 있습니다.

2.8.1.3. 전용 노드에 노드 유사성 및 허용 오차 사용

테인트를 사용하여 전용 노드를 생성한 다음 노드 유사성 및 허용 오차를 구성하여 전용 노드에 Kafka Pod를 예약합니다.

클러스터 관리자는 선택한 OpenShift 노드를 테인트로 표시할 수 있습니다. 테인트가 있는 노드는 일반 예약에서 제외되며 일반 Pod는 해당 예약에서 실행되도록 예약되지 않습니다. 노드에 설정된 테인트를 허용할 수 있는 서비스만 해당 노드에 예약할 수 있습니다. 이러한 노드에서 실행되는 다른 유일한 서비스는 로그 수집기 또는 소프트웨어 정의 네트워크와 같은 시스템 서비스가 됩니다.

Kafka 및 전용 노드에서 해당 구성 요소를 실행하면 많은 이점이 있을 수 있습니다. 동일한 노드에서 실행 중인 다른 애플리케이션이 없으므로 Kafka에 필요한 리소스를 중단하거나 사용할 수 있습니다. 이로 인해 성능이 향상되고 안정성이 향상될 수 있습니다.

2.8.2. 다른 작업자 노드에 각 Kafka 브로커를 예약하도록 Pod 유사성 방지 구성

많은 Kafka 브로커 또는 ZooKeeper 노드는 동일한 OpenShift 작업자 노드에서 실행할 수 있습니다. 작업자 노드가 실패하면 모두 동시에 사용할 수 없게 됩니다. 안정성을 높이기 위해 podAntiAffinity 구성을 사용하여 각 Kafka 브로커 또는 ZooKeeper 노드를 다른 OpenShift 작업자 노드에 예약할 수 있습니다.

사전 요구 사항

- OpenShift 클러스터

- 실행 중인 Cluster Operator

절차

클러스터 배포를 지정하는 리소스에서

유사성속성을 편집합니다. Kafka 브로커 또는 ZooKeeper 노드에서 작업자 노드를 공유하지 않도록 하려면strimzi.io/name라벨을 사용합니다.topologyKey를kubernetes.io/hostname으로 설정하여 선택한 Pod가 동일한 호스트 이름을 가진 노드에 예약되지 않도록 지정합니다. 이를 통해 단일 Kafka 브로커와 단일 ZooKeeper 노드에서 동일한 작업자 노드를 공유할 수 있습니다. 예를 들면 다음과 같습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 여기서

CLUSTER-NAME은 Kafka 사용자 지정 리소스의 이름입니다.Kafka 브로커와 ZooKeeper 노드가 동일한 작업자 노드를 공유하지 않도록 하려면

strimzi.io/cluster레이블을 사용합니다. 예를 들면 다음과 같습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 여기서

CLUSTER-NAME은 Kafka 사용자 지정 리소스의 이름입니다.리소스를 생성하거나 업데이트합니다.

oc apply -f <kafka_configuration_file>

oc apply -f <kafka_configuration_file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.8.3. Kafka 구성 요소에서 Pod 유사성 방지 구성

Pod 유사성 방지 구성은 Kafka 브로커의 안정성 및 성능을 지원합니다. podAntiAffinity 를 사용하면 OpenShift에서 다른 워크로드와 동일한 노드에 Kafka 브로커를 예약하지 않습니다. 일반적으로 데이터베이스, 스토리지 또는 기타 메시징 플랫폼과 같은 다른 네트워크 또는 스토리지 집약적 애플리케이션과 동일한 작업자 노드에서 실행되는 Kafka를 방지하려고 합니다.

사전 요구 사항

- OpenShift 클러스터

- 실행 중인 Cluster Operator

절차

클러스터 배포를 지정하는 리소스에서

유사성속성을 편집합니다. 라벨을 사용하여 동일한 노드에서 예약해서는 안 되는 pod를 지정합니다.topologyKey를kubernetes.io/hostname으로 설정하여 선택한 Pod를 동일한 호스트 이름이 있는 노드에 예약하지 않도록 지정해야 합니다. 예를 들면 다음과 같습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 리소스를 생성하거나 업데이트합니다.

이 작업은

oc apply를 사용하여 수행할 수 있습니다.oc apply -f <kafka_configuration_file>

oc apply -f <kafka_configuration_file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.8.4. Kafka 구성 요소에서 노드 선호도 구성

사전 요구 사항

- OpenShift 클러스터

- 실행 중인 Cluster Operator

절차

AMQ Streams 구성 요소를 예약해야 하는 노드에 레이블을 지정합니다.

이 작업은

oc label를 사용하여 수행할 수 있습니다.oc label node NAME-OF-NODE node-type=fast-network

oc label node NAME-OF-NODE node-type=fast-networkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 또는 기존 레이블 중 일부를 재사용할 수 있습니다.

클러스터 배포를 지정하는 리소스에서

유사성속성을 편집합니다. 예를 들면 다음과 같습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 리소스를 생성하거나 업데이트합니다.

이 작업은

oc apply를 사용하여 수행할 수 있습니다.oc apply -f <kafka_configuration_file>

oc apply -f <kafka_configuration_file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.8.5. 전용 노드 설정 및 Pod 예약

사전 요구 사항

- OpenShift 클러스터

- 실행 중인 Cluster Operator

절차

- 전용으로 사용할 노드를 선택합니다.

- 이러한 노드에 예약된 워크로드가 없는지 확인합니다.

선택한 노드에서 테인트를 설정합니다.

이 작업은

oc adm taint를 사용하여 수행할 수 있습니다.oc adm taint node NAME-OF-NODE dedicated=Kafka:NoSchedule

oc adm taint node NAME-OF-NODE dedicated=Kafka:NoScheduleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 또한 선택한 노드에도 레이블을 추가합니다.

이 작업은

oc label를 사용하여 수행할 수 있습니다.oc label node NAME-OF-NODE dedicated=Kafka

oc label node NAME-OF-NODE dedicated=KafkaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 클러스터 배포를 지정하는 리소스에서

유사성및허용 오차속성을 편집합니다.예를 들면 다음과 같습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 리소스를 생성하거나 업데이트합니다.

이 작업은

oc apply를 사용하여 수행할 수 있습니다.oc apply -f <kafka_configuration_file>

oc apply -f <kafka_configuration_file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.9. 로깅 구성

Kafka 구성 요소 및 AMQ Streams Operator의 사용자 정의 리소스에서 로깅 수준을 구성합니다. 사용자 정의 리소스의 spec.logging 속성에 직접 로깅 수준을 지정할 수 있습니다. 또는 configMapKeyRef 속성을 사용하여 사용자 정의 리소스에서 참조되는 ConfigMap에서 로깅 속성을 정의할 수 있습니다.

ConfigMap을 사용할 때의 이점은 로깅 속성이 한 위치에서 유지 관리되고 둘 이상의 리소스에서 액세스할 수 있다는 점입니다. 둘 이상의 리소스에 ConfigMap을 재사용할 수도 있습니다. ConfigMap을 사용하여 AMQ Streams Operator에 로거를 지정하는 경우 로깅 사양을 추가하여 필터를 추가할 수도 있습니다.

로깅 사양에 로깅 유형을 지정합니다.

-

로깅 수준을 직접 지정할 때

인라인 -

ConfigMap을 참조할 때

외부

인라인 로깅 구성 예

외부 로깅 구성의 예

ConfigMap의 이름과 키 값은 필수입니다. 이름 또는 키가 설정되지 않은 경우 기본 로깅이 사용됩니다.

2.9.1. Kafka 구성 요소 및 Operator의 로깅 옵션

특정 Kafka 구성 요소 또는 Operator에 대한 로깅 구성에 대한 자세한 내용은 다음 섹션을 참조하십시오.

Kafka 구성 요소 로깅

Operator 로깅

2.9.2. 로깅을 위한 ConfigMap 생성

ConfigMap을 사용하여 로깅 속성을 정의하려면 ConfigMap을 생성한 다음 리소스 사양에서 로깅 정의의 일부로 참조합니다.

ConfigMap에는 적절한 로깅 구성이 포함되어야 합니다.

-

Kafka 구성 요소, ZooKeeper 및 Kafka Bridge에 대한

log4j.properties -

Topic Operator 및 User Operator의

log4j2.properties

구성은 이러한 속성에 배치해야 합니다.

이 프로세스에서 ConfigMap은 Kafka 리소스에 대한 루트 로거를 정의합니다.

절차

ConfigMap을 생성합니다.

ConfigMap을 YAML 파일로 또는 속성 파일에서 생성할 수 있습니다.

Kafka에 대한 루트 로거 정의가 있는 ConfigMap 예:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow properties 파일을 사용하는 경우 명령줄에 파일을 지정합니다.

oc create configmap logging-configmap --from-file=log4j.properties

oc create configmap logging-configmap --from-file=log4j.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 속성 파일은 로깅 구성을 정의합니다.

Define the logger ...

# Define the logger kafka.root.logger.level="INFO" # ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 리소스

사양에외부 로깅을 정의하고logging.valueFrom.configMapKeyRef.name을 ConfigMap의 이름으로 설정하고logging.valueFrom.configMapKeyRef.key를 이 ConfigMap의 키로 설정합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 리소스를 생성하거나 업데이트합니다.

oc apply -f <kafka_configuration_file>

oc apply -f <kafka_configuration_file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.9.3. Operator에 로깅 필터 추가

ConfigMap을 사용하여 AMQ Streams Operator의 (log4j2) 로깅 수준을 구성하는 경우 로깅 필터를 정의하여 로그에 반환된 항목을 제한할 수도 있습니다.

로깅 필터는 많은 로깅 메시지가 있을 때 유용합니다. 로거의 로그 수준을 DEBUG(rootLogger.level="DEBUG")로 설정한다고 가정합니다. 로깅 필터는 해당 수준에서 로거에 대해 반환된 로그 수를 줄이므로 특정 리소스에 집중할 수 있습니다. 필터를 설정하면 필터와 일치하는 로그 메시지만 기록됩니다.

필터는 마커 를 사용하여 로그에 포함할 항목을 지정합니다. 마커의 종류, 네임스페이스 및 이름을 지정합니다. 예를 들어 Kafka 클러스터가 실패하는 경우 kind를 Kafka 로 지정하여 로그를 분리하고 실패한 클러스터의 네임스페이스와 이름을 사용할 수 있습니다.

이 예에서는 my-kafka-cluster 라는 Kafka 클러스터에 대한 마커 필터를 보여줍니다.

기본 로깅 필터 구성

rootLogger.level="INFO" appender.console.filter.filter1.type=MarkerFilter appender.console.filter.filter1.onMatch=ACCEPT appender.console.filter.filter1.onMismatch=DENY appender.console.filter.filter1.marker=Kafka(my-namespace/my-kafka-cluster)

rootLogger.level="INFO"

appender.console.filter.filter1.type=MarkerFilter

appender.console.filter.filter1.onMatch=ACCEPT

appender.console.filter.filter1.onMismatch=DENY

appender.console.filter.filter1.marker=Kafka(my-namespace/my-kafka-cluster) 하나 이상의 필터를 만들 수 있습니다. 여기에서는 두 개의 Kafka 클러스터에 대해 로그가 필터링됩니다.

다중 로깅 필터 구성

Cluster Operator에 필터 추가

Cluster Operator에 필터를 추가하려면 로깅 ConfigMap YAML 파일(install/cluster-operator/050-ConfigMap-strimzi-cluster-operator.yaml)을 업데이트합니다.

절차

050-ConfigMap-strimzi-cluster-operator.yaml파일을 업데이트하여 ConfigMap에 필터 속성을 추가합니다.이 예에서 filter 속성은

my-kafka-clusterKafka 클러스터에 대해서만 로그를 반환합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 또는

ConfigMap을 직접 편집합니다.oc edit configmap strimzi-cluster-operator

oc edit configmap strimzi-cluster-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow ConfigMap을 직접 편집하지 않고 YAML 파일을 업데이트한 경우

ConfigMap을 배포하여 변경 사항을 적용합니다.oc create -f install/cluster-operator/050-ConfigMap-strimzi-cluster-operator.yaml

oc create -f install/cluster-operator/050-ConfigMap-strimzi-cluster-operator.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Topic Operator 또는 User Operator에 필터 추가

Topic Operator 또는 User Operator에 필터를 추가하려면 로깅 ConfigMap을 생성하거나 편집합니다.

이 절차에서는 Topic Operator에 대한 필터를 사용하여 로깅 ConfigMap을 생성합니다. 동일한 접근 방식이 User Operator에 사용됩니다.

절차

ConfigMap을 생성합니다.

ConfigMap을 YAML 파일로 또는 속성 파일에서 생성할 수 있습니다.

이 예에서 필터 속성은

my-topic항목에 대해서만 로그를 반환합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow properties 파일을 사용하는 경우 명령줄에 파일을 지정합니다.

oc create configmap logging-configmap --from-file=log4j2.properties

oc create configmap logging-configmap --from-file=log4j2.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 속성 파일은 로깅 구성을 정의합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 리소스

사양에외부 로깅을 정의하고logging.valueFrom.configMapKeyRef.name을 ConfigMap의 이름으로 설정하고logging.valueFrom.configMapKeyRef.key를 이 ConfigMap의 키로 설정합니다.Topic Operator의 경우

Kafka리소스의topicOperator구성에 로깅이 지정됩니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Cluster Operator를 배포하여 변경 사항을 적용합니다.

create -f install/cluster-operator -n my-cluster-operator-namespace

create -f install/cluster-operator -n my-cluster-operator-namespace3장. 외부 소스에서 구성 값 로드

구성 공급자 플러그인을 사용하여 외부 소스에서 구성 데이터를 로드합니다. 공급자는 AMQ Streams와 독립적으로 작동합니다. 이를 사용하여 생산자 및 소비자를 포함한 모든 Kafka 구성 요소의 구성 데이터를 로드할 수 있습니다. 예를 들어 Kafka Connect 커넥터 구성에 대한 인증 정보를 제공하는 등의 작업을 사용합니다.