架构

OpenShift Container Platform 3.11 架构信息

摘要

第 1 章 概述

OpenShift v3 是一个分层的系统,它用于公开底层 Docker 格式的容器镜像和 Kubernetes 概念,其目的是使开发人员可以轻松地开发和部署应用程序。例如,安装 Ruby、推送代码和添加 MySQL。

与 OpenShift v2 相比,它在创建模型的所有方面后,提供了更加灵活的配置。作为单独的对象,应用程序的概念被移除以更灵活的"服务"组成,允许两个 web 容器重复使用数据库或将数据库直接公开给网络边缘。

1.1. 什么是层?

Docker 服务为打包和创建基于 Linux 的轻量级容器镜像提供了一个抽象层。Kubernetes 提供 集群管理功能,并可以在多个主机上编配容器。

OpenShift Container Platform 增加了:

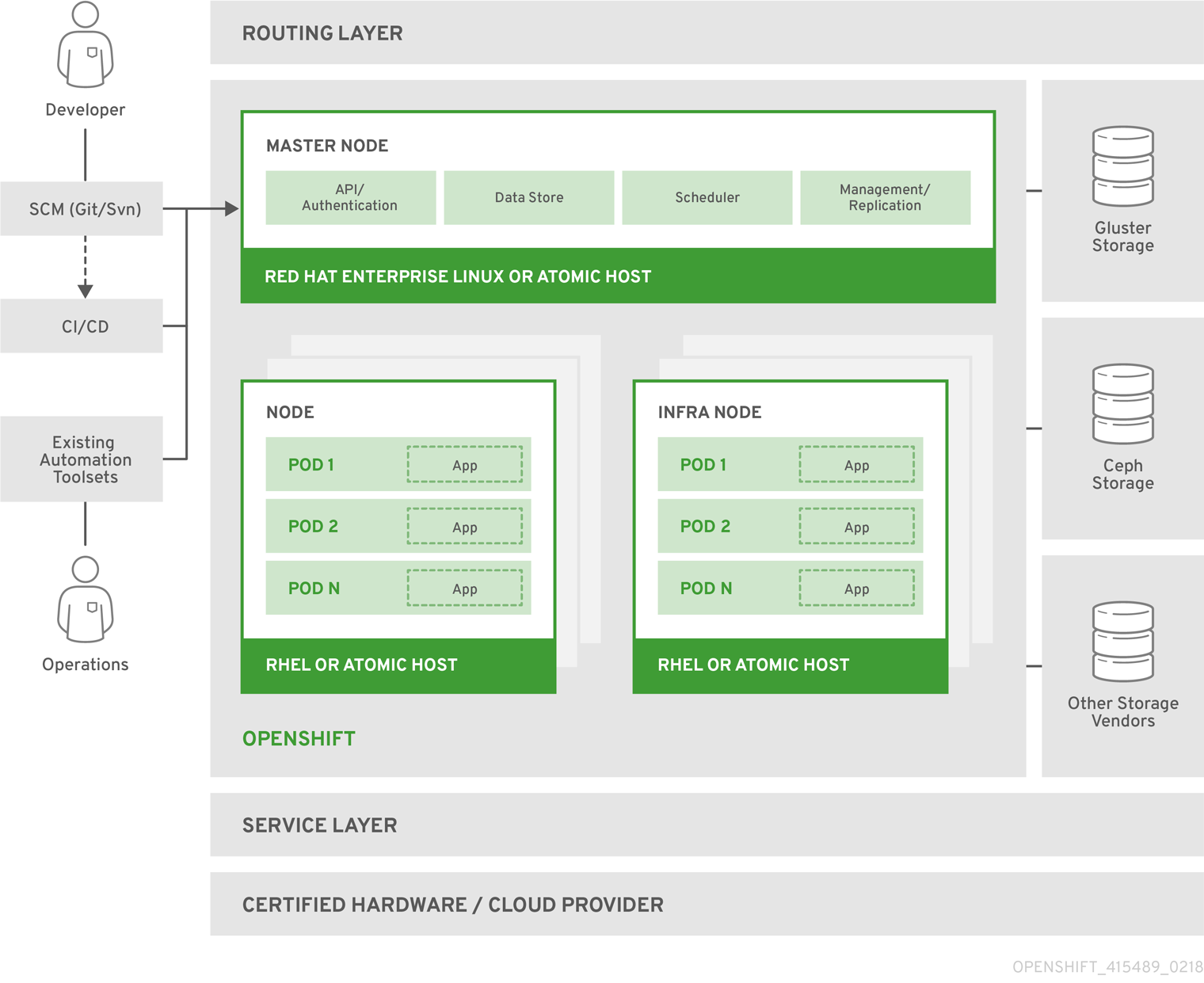

图 1.1. OpenShift Container Platform 架构概述

如需有关架构概述中的节点类型的更多信息,请参阅 Kubernetes 基础架构。

1.2. OpenShift Container Platform 架构是什么?

OpenShift Container Platform 有一个基于微服务的架构,具有可一起工作的较小且分离的单元。它运行在 Kubernetes 集群 之上,其中包含有关 etcd 中存储的对象的数据,它是一个可靠的集群键值存储。这些服务按功能划分:

用户调用 REST API 以更改系统的状态。控制器使用 REST API 来读取用户所需状态,然后尝试让系统的其他部分保持同步。例如,当用户请求创建 "build" 对象的构建时。构建控制器会看到已创建了新构建,并在集群上运行一个进程来执行该构建。构建完成后,控制器通过 REST API 更新构建对象,用户会看到其构建已经完成。

控制器模式意味着 OpenShift Container Platform 中的大部分功能是可扩展的。构建运行和启动的方式可以独立自定义管理镜像的方式,或者如何部署。控制器正在执行系统的"业务逻辑",采取用户操作并将其转换为现实。通过自定义这些控制器或将其替换为您自己的逻辑,可以实施不同的行为。从系统管理的角度来看,这也意味着 API 可用于根据重复的计划编写常见的管理操作。这些脚本也是监视更改和采取行动的控制器。OpenShift Container Platform 使可以采用第一类行为来自定义集群。

要实现这个目标,控制器利用系统的一个可靠的更改流,将其系统视图与用户执行的操作同步。此事件流会从 etcd 推送到 REST API,然后在更改后马上推送到控制器,因此更改可以快速高效地通过系统进行传输。但是,由于任何时候都可能会出现故障,控制器还必须能够在启动时获得系统的最新状态,并确认所有内容都处于正确的状态。这个重新同步(resynchronization)功能很重要,因为这意味着即使出现问题,Operator 也可以重启受影响的组件,系统会在继续前双重检查所有信息。系统最终应聚合到用户的意图,因为控制器总是可以使系统进行同步。

1.3. OpenShift Container Platform 如何安全?

OpenShift Container Platform 和 Kubernetes API 会验证带有凭证的用户的身份,然后根据其角色授权它们。开发人员和管理员可以通过多种方法进行身份验证,主要通过 OAuth 令牌和 X.509 客户端证书进行身份验证。OAuth 令牌使用 JSON Web Algorithm RS256 签名,这是带有 SHA-256 的 RSA 签名算法 PKCS#1 v1.5。

开发人员(系统客户端)通常从 oc 或 web 控制台 等 客户端程序发出 REST API 调用,并使用 OAuth bearer 令牌进行大部分通信。基础架构组件(如节点)使用由系统中包含其身份的客户端证书。在容器中运行的基础架构组件使用与其 服务帐户关联的 令牌来连接到 API。

授权在 OpenShift Container Platform 策略引擎中处理,它定义诸如 "create pod" 或 "list services" 的操作,并将它们分组到策略文档中的角色。角色通过用户或组标识符绑定到用户或组。当用户或服务帐户尝试操作时,策略引擎会检查一个或多个分配给该用户的角色(例如,集群管理员或当前项目的管理员),然后再继续。

由于集群中运行的每个容器都与服务帐户关联,因此也可以将 secret 与这些服务帐户关联,并将其自动传送到容器中。这可让基础架构管理用于拉取和推送镜像、构建和部署组件的 secret,同时还允许应用程序代码轻松利用这些 secret。

1.3.1. TLS 支持

所有与 REST API 的通信频道以及 etcd 和 API 服务器等 master 组件 之间都使用 TLS 保护。TLS 提供具有 X.509 服务器证书和公钥基础架构的强大加密、数据完整性和验证服务器。默认情况下,会为每个 OpenShift Container Platform 部署创建一个新的内部 PKI。内部 PKI 使用 2048 位 RSA 密钥和 SHA-256 签名。也支持公共主机的 自定义证书。

OpenShift Container Platform 使用 Golang 的 crypto/tls 的标准库实现,且不依赖于任何外部加密和 TLS 库。另外,客户端依赖于用于 GSSAPI 验证和 OpenPGP 签名的外部库。GSSAPI 通常由 MIT Kerberos 或 Heimdal Kerberos 提供,它们都使用 OpenSSL 的 libcrypto。OpenPGP 签名验证由 libgpgme 和 GnuPG 处理。

不安全的版本 SSL 2.0 和 SSL 3.0 不受支持,且不可用。OpenShift Container Platform 服务器和 oc 客户端默认只提供 TLS 1.2。TLS 1.0 和 TLS 1.1 可以在服务器配置中启用。服务器和客户端都首选使用经过身份验证的加密算法和完美转发保密性实现现代加密套件。禁用使用已弃用和不安全的算法(如 RC4、3DES 和 MD5)的密码套件。有些内部客户端(例如,LDAP 身份验证)限制了启用了 1.2 和更多密码套件的 TLS 1.0 的设置。

| TLS 版本 | OpenShift Container Platform Server | oc Client | 其他客户端 |

|---|---|---|---|

| SSL 2.0 | 不支持 | 不支持 | 不支持 |

| SSL 3.0 | 不支持 | 不支持 | 不支持 |

| TLS 1.0 | 没有 [1] | 没有 [1] | 或许 [2] |

| TLS 1.1 | 没有 [1] | 没有 [1] | 或许 [2] |

| TLS 1.2 | 是 | 是 | 是 |

| TLS 1.3 | N/A [3] | N/A [3] | N/A [3] |

- 默认禁用,但在服务器配置中可以启用。

- 一些内部客户端,如 LDAP 客户端。

- TLS 1.3 仍在开发中。

以下列出的 OpenShift Container Platform 服务器和 oc 客户端的启用密码套件按首选顺序排序:

-

TLS_ECDHE_ECDSA_WITH_CHACHA20_POLY1305 -

TLS_ECDHE_RSA_WITH_CHACHA20_POLY1305 -

TLS_ECDHE_ECDSA_WITH_AES_128_GCM_SHA256 -

TLS_ECDHE_RSA_WITH_AES_128_GCM_SHA256 -

TLS_ECDHE_ECDSA_WITH_AES_256_GCM_SHA384 -

TLS_ECDHE_RSA_WITH_AES_256_GCM_SHA384 -

TLS_ECDHE_ECDSA_WITH_AES_128_CBC_SHA256 -

TLS_ECDHE_RSA_WITH_AES_128_CBC_SHA256 -

TLS_ECDHE_ECDSA_WITH_AES_128_CBC_SHA -

TLS_ECDHE_ECDSA_WITH_AES_256_CBC_SHA -

TLS_ECDHE_RSA_WITH_AES_128_CBC_SHA -

TLS_ECDHE_RSA_WITH_AES_256_CBC_SHA -

TLS_RSA_WITH_AES_128_GCM_SHA256 -

TLS_RSA_WITH_AES_256_GCM_SHA384 -

TLS_RSA_WITH_AES_128_CBC_SHA -

TLS_RSA_WITH_AES_256_CBC_SHA

第 2 章 基础架构组件

2.1. Kubernetes 基础架构

2.1.1. 概述

在 OpenShift Container Platform 中,Kubernetes 在一组容器或主机间管理容器化应用,并提供部署、维护和应用程序的扩展机制。容器运行时软件包、实例化和运行容器化应用。Kubernetes 集群由一个或多个 master 和一组节点组成。

您可以选择将 master 配置为高可用性 (HA),以确保集群没有单点故障。

OpenShift Container Platform 使用 Kubernetes 1.11 和 Docker 1.13.1。

2.1.2. Master

master 是包含 control plane 组件的主机或主机,包括 API 服务器、控制器管理器服务器和 etcd。master 用于管理其 Kubernetes 集群中的节点,并调度 pod 以便在这些节点上运行。

| 组件 | 描述 |

|---|---|

| API Server | Kubernetes API 服务器验证并配置 pod、服务和复制控制器的数据。它还将 pod 分配给节点,并将 pod 信息与服务配置同步。 |

| etcd | etcd 存储持久 master 状态,而其他组件会监视 etcd 的更改,以自行进入所需状态。etcd 可以配置为高可用性,通常使用 2n+1 对等服务部署。 |

| Controller Manager Server | 控制器管理器服务器监视 etcd 是否有复制控制器对象的更改,然后使用 API 强制执行所需的状态。多个这样的过程会创建在某个时间点上有一个活跃群首的集群。 |

| HAProxy |

可选,用于配置高可用性 master,使用 |

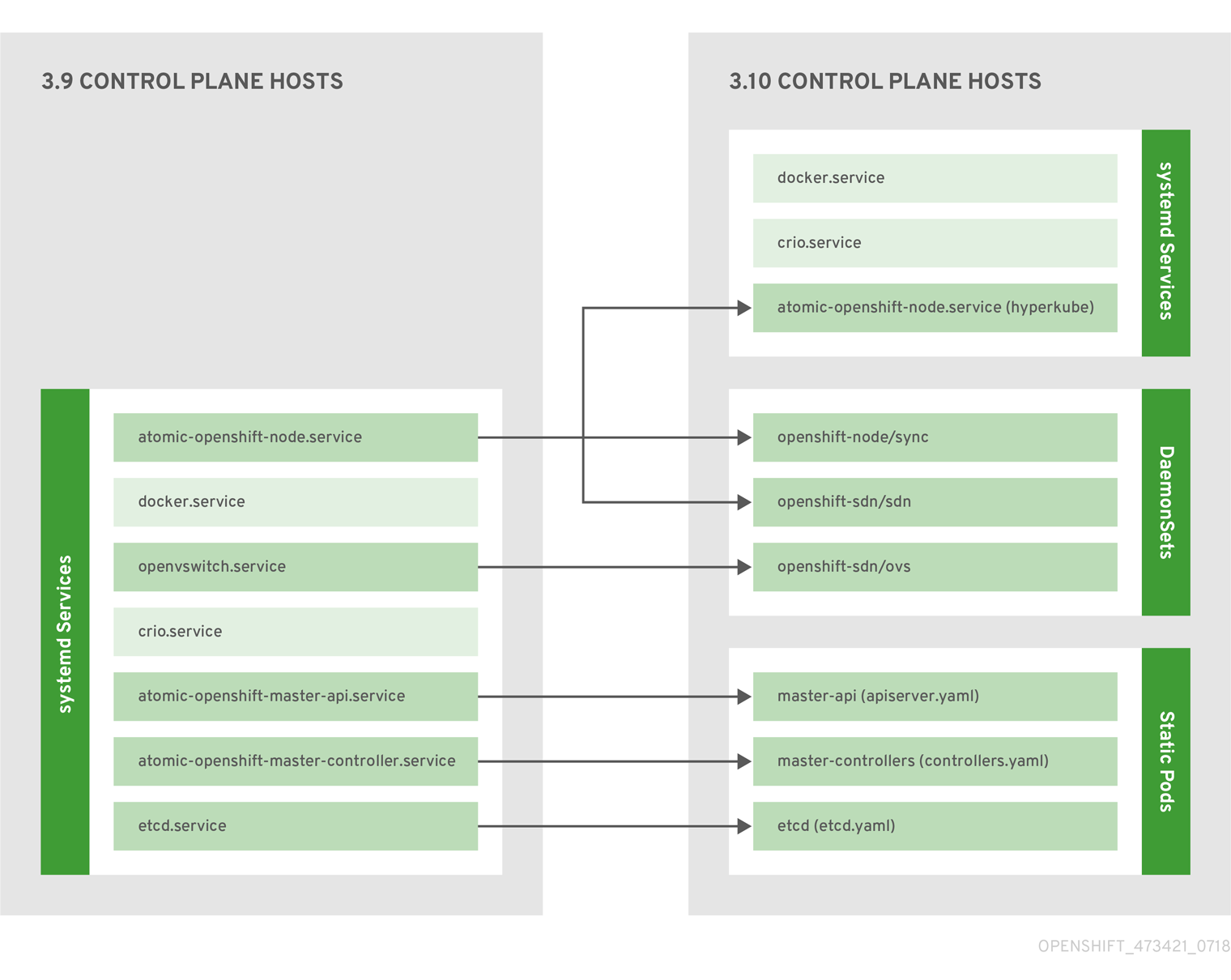

2.1.2.1. Control Plane 静态 Pod

核心 control plane 组件、API 服务器和控制器管理器组件,作为 kubelet 操作 的静态 pod 运行。

对于在同一主机上还存在 etcd 的 master,etcd 也会变为静态 pod。在不是 master 的 etcd 主机上仍然支持基于 RPM 的 etcd。

另外,节点组件 openshift-sdn 和 openvswitch 现在可以使用 DaemonSet 而不是 systemd 服务运行。

图 2.1. control plane 主机架构更改

即使作为静态 pod 运行 control plane 组件,master 主机仍然会从 /etc/origin/master/master-config.yaml 文件中提供其配置,如 Master 和 Node Configuration 所述。

启动序列概述

Hyperkube 是一个包含所有 Kubernetes 的二进制文件(kube-apiserver, controller-manager, scheduler, proxy, 和 kubelet)。在启动时,kubelet 创建 kubepods.slice。接下来,kubelet 在 kubepods.slice 中创建 QoS 级别片段 burstable.slice 和 best-effort.slice。当 pod 启动时,kubelet 使用格式为 pod< UUID-of-pod>.slice 的 pod 级别片段,并将该路径传递给容器运行时接口(CRI)的另一端的运行时。然后,Docker 或 CRI-O 会在 pod 级别片段中创建容器级别的片段。

镜像 Pod

master 节点上的 kubelet 会自动在 API 服务器上为每个 control plane 静态 pod 创建镜像 pod,以便 kube-system 项目中的集群可见。默认情况下,openshift-ansible 安装程序会安装这些静态 pod 的清单,位于 master 主机上的 /etc/origin/node/pods 目录中。

这些 pod 定义了以下 hostPath 卷:

| /etc/origin/master | 包含所有证书、配置文件和 admin.kubeconfig 文件。 |

| /var/lib/origin | 包含二进制文件的卷和潜在的内核转储。 |

| /etc/origin/cloudprovider | 包含特定于云供应商的配置(AWS、Azure 等)。 |

| /usr/libexec/kubernetes/kubelet-plugins | 包含其他第三方卷插件。 |

| /etc/origin/kubelet-plugins | 包含系统容器的其他第三方卷插件。 |

您可以在静态 pod 上执行的操作集合有限。例如:

oc logs master-api-<hostname> -n kube-system

$ oc logs master-api-<hostname> -n kube-system返回 API 服务器的标准输出。然而:

oc delete pod master-api-<hostname> -n kube-system

$ oc delete pod master-api-<hostname> -n kube-system不会实际删除 pod。

再如,集群管理员可能需要执行一个常见操作,如增加 API 服务器的日志级别,以便在出现问题时提供更详细的数据。您必须编辑 /etc/origin/master/master.env 文件,其中 OPTIONS 变量中的 --loglevel 参数可以被修改,因为此值被传递给容器中运行的进程。更改需要重启容器中运行的进程。

重启主服务

要重启在 control plane 静态 pod 中运行的 control plane 服务,请在 master 主机上使用 master-restart 命令。

重启 master API:

master-restart api

# master-restart api重启控制器:

master-restart controllers

# master-restart controllers重启 etcd:

master-restart etcd

# master-restart etcd查看主服务日志

要查看在 control plane 静态 pod 中运行的 control plane 服务的日志,请为对应的组件使用 master-logs 命令:

master-logs api api

# master-logs api apimaster-logs controllers controllers

# master-logs controllers controllersmaster-logs etcd etcd

# master-logs etcd etcd2.1.2.2. 高可用性 Master

您可以选择将 master 配置为高可用性(HA),以确保集群没有单点故障。

要减少有关 master 可用性的问题,建议进行两个操作:

在生产环境的 OpenShift Container Platform 集群中,您必须维护 API 服务器负载均衡器的高可用性。如果 API 服务器负载均衡器不可用,节点无法报告其状态,则所有 pod 都会标记为 dead,pod 的端点也会从服务中删除。

除了为 OpenShift Container Platform 配置 HA 之外,还必须为 API 服务器负载均衡器单独配置 HA。要配置 HA,最好集成一个企业负载均衡器(LB),例如 F5 Big-IP™ 或 Citrix Netscaler™ 设备。如果此类解决方案不可用,可以运行多个 HAProxy 负载均衡器,并使用 Keepalived 为 HA 提供浮动虚拟 IP 地址。但是,不建议在生产环境中使用这个解决方案。

当在 HAProxy 中 使用原生 HA 方法时,master 组件有以下可用性:

| 角色 | 样式 | 备注 |

|---|---|---|

| etcd | Active-active | 具有负载平衡的完全冗余部署。可以安装在单独的主机上,也可以将 collocated 安装到 master 主机上。 |

| API Server | Active-active | 由 HAProxy 管理. |

| Controller Manager Server | Active-passive | 一个实例被选为集群领导。 |

| HAProxy | Active-passive | 在 API 主(master)端点之间进行负载平衡。 |

虽然集群 etcd 需要奇数个主机的仲裁数,但 master 服务没有奇数个主机的仲裁数或要求。但是,因为您需要至少两个 master 服务用于 HA,因此在找到 master 服务和 etcd 时,通常要维护一个统一奇数的主机。

2.1.3. 节点

节点为容器提供运行时环境。Kubernetes 群集中的每个节点都需要由主控机管理的服务。节点也具有运行 pod 所需的服务,包括容器运行时、kubelet 和服务代理。

OpenShift Container Platform 从云供应商、物理系统或虚拟系统创建节点。Kubernetes 与代表这些节点的节点对象进行交互。主控机(master)使用来自节点对象的信息执行健康检查,以此验证节点。在通过健康检查前,节点会被忽略,master 会继续检查节点,直到节点有效。Kubernetes 文档包含有关节点状态和管理的更多信息。

管理员可以使用 CLI 在 OpenShift Container Platform 实例中管理节点。要在启动节点服务器时定义完整的配置和安全选项,请使用 专用节点配置文件。

有关推荐的节点数,请参阅集群限制部分。

2.1.3.1. kubelet

每个节点都有一个 kubelet,它更新由容器清单指定的节点,它是一个描述 pod 的 YAML 文件。kubelet 使用一组清单来确保其容器已启动并且它们继续运行。

容器清单可以通过以下方法提供给 kubelet:

- 命令行中每 20 秒检查一次的文件路径。

- 一个 HTTP 端点会传递到命令行,它每 20 秒检查一次。

- kubelet 监视 etcd 服务器,如 /registry/hosts/$(hostname -f),并作用于任何更改。

- kubelet 侦听 HTTP 并响应简单的 API 来提交新清单。

2.1.3.2. 服务代理

每个节点还运行一个简单的网络代理,它反映了节点上 API 中定义的服务。这允许节点在一组后端上执行简单的 TCP 和 UDP 流转发。

2.1.3.3. 节点对象定义

以下是 Kubernetes 中的节点对象定义示例:

2.1.3.4. 节点引导

节点的配置从 master 启动,这意味着节点会从 master 拉取其预定义配置和服务器证书。这可通过减少节点之间的区别以及集中更多配置并让集群在所需状态进行聚合,从而加快节点启动速度。证书轮转和集中式证书管理会被默认启用。

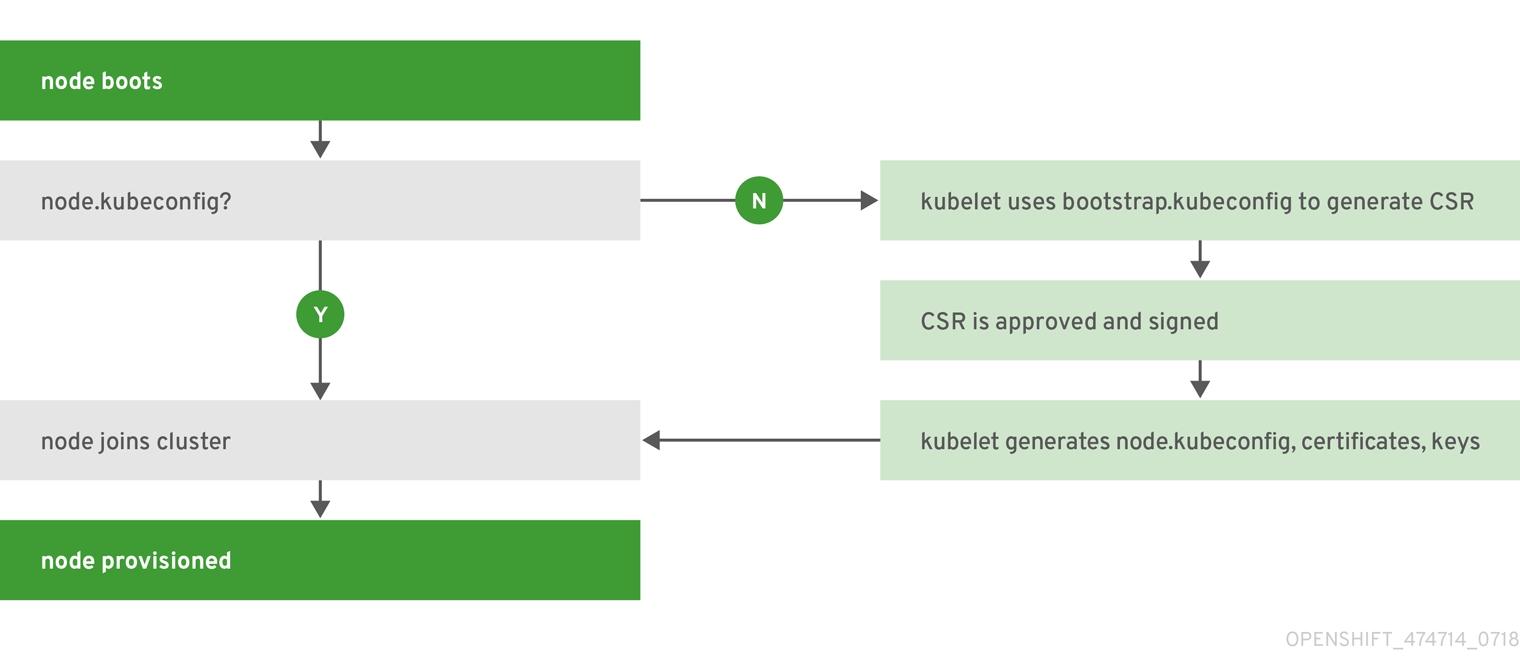

图 2.2. 节点 bootstrap 工作流概述

当节点服务启动时,节点会在加入集群前检查 /etc/origin/node/node.kubeconfig 文件和其他节点配置文件是否存在。如果不存在,节点将从 master 中拉取配置,然后加入集群。

ConfigMap 用于在集群中存储节点配置,这会在节点主机上的 /etc/origin/node/node-config.yaml 填充配置文件。有关默认节点组及其 ConfigMap 集合的定义,请参阅在安装集群中定义节点组和主机映射。

节点 Bootstrap 工作流

自动节点 bootstrap 过程使用以下工作流:

默认情况下,会在集群安装过程中创建一组

clusterrole、clusterrolebinding和serviceaccount对象以用于节点引导:system:node-bootstrapper 集群角色用于在节点引导期间创建证书签名请求(CSR):

oc describe clusterrole.authorization.openshift.io/system:node-bootstrapper

$ oc describe clusterrole.authorization.openshift.io/system:node-bootstrapperCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下 node-bootstrapper 服务帐户是在 openshift-infra 项目中创建的:

oc describe sa node-bootstrapper -n openshift-infra

$ oc describe sa node-bootstrapper -n openshift-infraCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下 system:node-bootstrapper 集群角色绑定用于节点 bootstrapper 集群角色和服务帐户:

oc describe clusterrolebindings system:node-bootstrapper

$ oc describe clusterrolebindings system:node-bootstrapperCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

另外,在集群安装过程中,openshift-ansible 安装程序会在 /etc/origin/master 目录中创建 OpenShift Container Platform 证书颁发机构和各种其他证书、密钥和 kubeconfig 文件。注意的两个文件有:

/etc/origin/master/admin.kubeconfig

使用 system:admin 用户。

/etc/origin/master/bootstrap.kubeconfig

用于不是 master 节点的 bootstrap 节点。

在安装程序使用 node-bootstrapper 服务帐户时,会创建 /etc/origin/master/bootstrap.kubeconfig,如下所示:

oc --config=/etc/origin/master/admin.kubeconfig \ serviceaccounts create-kubeconfig node-bootstrapper \ -n openshift-infra$ oc --config=/etc/origin/master/admin.kubeconfig \ serviceaccounts create-kubeconfig node-bootstrapper \ -n openshift-infraCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 在 master 节点上,/etc/origin/master/admin.kubeconfig 用作引导文件,并复制到 /etc/origin/node/boostrap.kubeconfig。在另外一个非 master 节点上,/etc/origin/master/bootstrap.kubeconfig 文件会复制到每个节点主机上的 /etc/origin/node/boostrap.kubeconfig 的所有其他节点上。

然后,使用

--bootstrap-kubeconfig标记将 /etc/origin/master/bootstrap.kubeconfig 传递给 kubelet,如下所示:--bootstrap-kubeconfig=/etc/origin/node/bootstrap.kubeconfig

--bootstrap-kubeconfig=/etc/origin/node/bootstrap.kubeconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- kubelet 首先使用提供的 /etc/origin/node/bootstrap.kubeconfig 文件启动。在初始内部连接后,kubelet 创建证书签名请求(CSR)并将其发送到 master。

CSR 通过控制器管理器(特别是证书签名请求)进行验证和批准。如果批准,kubelet 客户端和服务器证书会在 /etc/origin/node/ceritificates 目录中创建。例如:

ls -al /etc/origin/node/certificates/

# ls -al /etc/origin/node/certificates/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 在 CSR 批准后,node.kubeconfig 文件会在 /etc/origin/node/node.kubeconfig 中创建。

- kubelet 使用 /etc/origin/node/node.kubeconfig 文件以及 /etc/origin/node/certificates/ 目录中的证书重启,直到它准备好加入集群。

节点配置工作流

为节点配置提供使用以下工作流:

- 最初,节点的 kubelet 是在节点置备时创建的 /etc/origin/node/ 目录中的 bootstrap-node-config.yaml 启动。

- 在每个节点上,节点服务文件使用 /usr/local/bin/ 目录中的本地脚本 openshift-node 来通过提供的 bootstrap-node-config.yaml 启动 kubelet。

- 在每个 master 上,目录 /etc/origin/node/pods 包含 apiserver 的 pod 清单,控制器和 etcd 在 master 上作为静态 pod 创建。

在集群安装过程中,会创建一个同步 DaemonSet,在每个节点上创建一个同步 pod。sync(同步)pod 会监控文件 /etc/sysconfig/atomic-openshift-node 中的更改。它专门用于监视要设置的

BOOTSTRAP_CONFIG_NAME。BOOTSTRAP_CONFIG_NAME由 openshift-ansible 安装程序设置,它是根据节点所属节点配置组的 ConfigMap 名称。默认情况下,安装程序会创建以下节点配置组:

- node-config-master

- node-config-infra

- node-config-compute

- node-config-all-in-one

- node-config-master-infra

在 openshift-node 项目中为每个组创建一个 ConfigMap。

-

同步 pod 根据

BOOTSTRAP_CONFIG_NAME中设置的值提取适当的 ConfigMap。 - 同步 pod 将 ConfigMap 数据转换为 kubelet 配置,并为该节点主机创建一个 /etc/origin/node/node-config.yaml。如果对此文件进行了更改(或者是文件的初始创建),则 kubelet 会重启。

修改节点配置

通过编辑 openshift-node 项目中的相应 ConfigMap 来修改节点的配置。不要直接修改 /etc/origin/node/node-config.yaml。

例如,对于 node-config-compute 组中的节点,使用以下内容编辑 ConfigMap:

oc edit cm node-config-compute -n openshift-node

$ oc edit cm node-config-compute -n openshift-node2.2. 容器 Registry

2.2.1. 概述

OpenShift Container Platform 可以使用实施容器镜像 registry API 的任何服务器作为镜像源,包括 Docker Hub、由第三方运行的私有 registry 和集成的 OpenShift Container Platform registry。

2.2.2. 集成的 OpenShift Container Registry

OpenShift Container Platform 提供了一个集成的容器镜像 registry,称为 OpenShift Container Registry (OCR),它可按需自动置备新的镜像存储库。这为用户提供一个内置位置,供其应用构建用于推送生成的镜像。

每当一个新镜像推送到 OCR 时,registry 就会通知 OpenShift Container Platform,同时传递有关新镜像的所有信息,如命名空间、名称和镜像元数据。OpenShift Container Platform 的不同部分对新镜像做出反应,创建新的构建和部署。

OCR 也可以作为独立组件部署,它只作为容器镜像 registry,而无需构建和部署集成。详情请参阅安装独立 OpenShift Container Registry 部署的内容。

2.2.3. 第三方 registry

OpenShift Container Platform可以使用由第三方 registry 提供的镜像创建容器,但是这些registry 可能不会象OpenShift Container Platform中集成的registry一样提供相同的镜像通知支持。在这种情况下,OpenShift Container Platform将在创建镜像流时从远程 registry 中获取 tag。oc import-image <stream>就可以更新获取的 tag。当检测到新的镜像时,以前的构建和部署将会被重新创建。

2.2.3.1. 身份验证

OpenShift Container Platform 使用用户提供的凭证与 registry 进行联系来访问私有镜像仓库。这样,OpenShift Container Platform就可以对私有仓库进行镜像的 push 和 pull 操作。身份验证包含更多信息。

2.2.4. Red Hat Quay registry

Red Hat Quay 为您提供了一个企业级的容器镜像 registry。它可以作为一个托管的服务,也可以在您自己的数据中心或环境中安装它。Red Hat Quay中的高级 registry 功能包括跨区域复制、镜像扫描及镜像回滚(roll back)功能。

请通过 Quay.io 网站设置您自己的托管 Quay registry 帐户。之后,按照 Quay 教程登录到 Quay registry,并开始管理镜像。另外,请参阅 Red Hat Quay 入门,以了解有关设置您自己的 Red Hat Quay registry 的信息。

您可以象访问其他远程镜像 registry 一样,通过 OpenShift Container Platform 访问您的 Red Hat Quay registry。要了解如何设置将凭证作为安全 registry 访问 Red Hat Quay,请参阅 允许 Pod 从其他安全 registry 中引用镜像。

2.2.5. 启用身份验证的 Red Hat Registry

Red Hat Container Catalog (registry.access.redhat.com)是一个托管的镜像 registry,通过它可以获得所需的容器镜像。OpenShift Container Platform 3.11 Red Hat Container Catalog 从 registry.access.redhat.com 移到 registry.redhat.io。

新的 registry(Registry.redhat.io)需要进行身份验证才能访问OpenShift Container Platform上的镜像及内容。当迁移到新registry后,现有的registry仍将在一段时间内可用。

OpenShift Container Platform从Registry.redhat.io中提取(pull)镜像,因此需要配置集群以使用它。

新registry使用标准的OAuth机制进行身份验证:

- 身份验证令牌。令牌(token)是服务帐户,由管理员生成。系统可以使用它们与容器镜像registry进行身份验证。服务帐户不受用户帐户更改的影响,因此使用令牌进行身份验证是一个可靠且具有弹性的方法。这是生产环境集群中唯一受支持的身份验证选项。

-

Web用户名和密码。这是用于登录到诸如

access.redhat.com之类的资源的标准凭据集。虽然可以在OpenShift Container Platform上使用此身份验证方法,但在生产环境部署中不支持此方法。此身份验证方法应该只限于在OpenShift Container Platform之外的独立项目中使用。

您可以在 docker login 中使用您的凭证(用户名和密码,或身份验证令牌)来访问新 registry 中的内容。

所有镜像流均指向新的registry。由于新 registry 需要进行身份验证才能访问,因此 OpenShift 命名空间中有一个名为 imagestreamsecret 的新机密。

您需要将凭据放在两个位置:

- OpenShift 命名空间 。您的凭据必须存在于 OpenShift 命名空间中,以便 OpenShift 命名空间中的镜像流可以导入。

- 您的主机。您的凭据必须存在于主机上,因为在抓取(pull)镜像时,Kubernetes会使用主机中的凭据。

访问新 registry:

-

验证镜像导入 secret(

imagestreamsecret)是否位于 OpenShift 命名空间中。该 secret 具有允许您访问新 registry 的凭证。 -

验证所有集群节点都有一个

/var/lib/origin/.docker/config.json,可以从 master 中复制,供您访问红帽 registry。

2.3. Web 控制台

2.3.1. 概述

OpenShift Container Platform Web控制台是可从Web浏览器访问的用户界面。开发人员可以使用 Web 控制台来视觉化、浏览和管理 项目 的内容。

必须启用JavaScript才能使用Web控制台。为获得最佳体验,请使用支持WebSockets的Web浏览器。

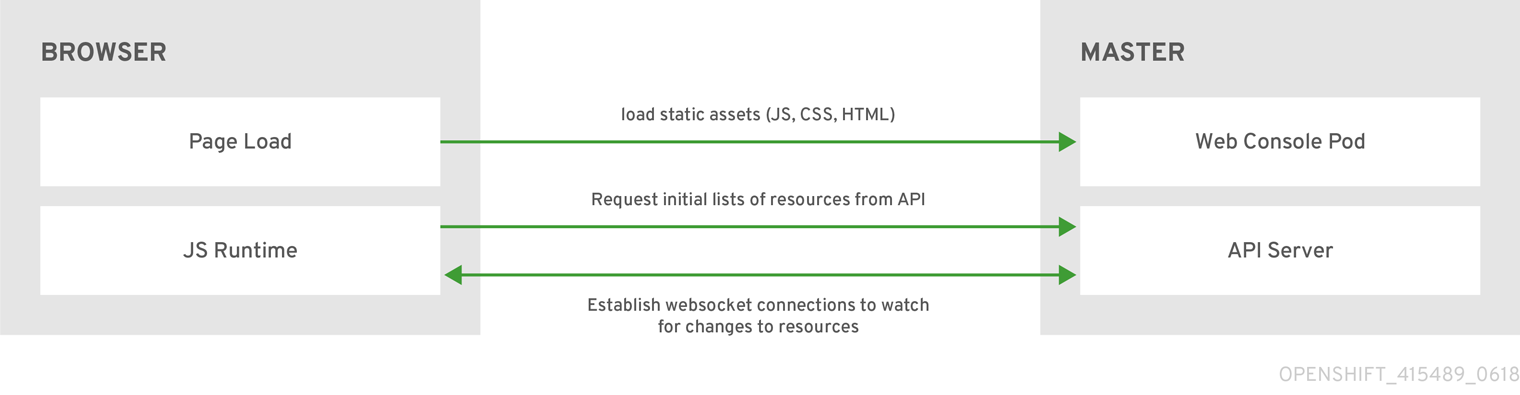

Web 控制台作为 pod 在 master 上运行。这个 pod 提供了运行Web控制台所需的静态环境。管理员也可以使用扩展 自定义 Web 控制台,您可以在 web控制台加载时运行脚本和加载自定义样式表。

当您从浏览器访问 Web 控制台时,它会首先加载所有所需的静态资产。然后,它使用 openshift start 选项 --public-master 或在 openshift-console-config 配置映射中定义的 webconsole-config 配置映射中的相关参数 masterPublicURL 向 OpenShift Container Platform API 发出请求。Web 控制台使用 WebSockets 来保持与 API 服务器的持久连接,并在可用后立即收到更新的信息。

图 2.3. Web 控制台请求架构

为 web 控制台配置的主机名和 IP 地址列入白名单,以便安全地访问 API 服务器,即使浏览器将请求视为 跨原始状态。要使用其他主机名从 web 应用程序访问 API 服务器,您必须通过将 --cors-allowed-origins 选项指定 openshift start 或从相关的 master 配置文件参数 corsAllowedOrigins 指定主机名来列入白名单。

corsAllowedOrigins 参数由配置字段控制。不会对值进行固定或转义。以下是如何获得主机名和转义点的示例:

corsAllowedOrigins: - (?i)//my\.subdomain\.domain\.com(:|\z)

corsAllowedOrigins:

- (?i)//my\.subdomain\.domain\.com(:|\z)-

(?i)使它不区分大小写。 -

//固定到域的开头(并匹配http:或https:后面的双斜杠)。 -

\.对域名中的点进行转义。 -

(:|\z)匹配域名末尾(\z)或端口分隔符(:)。

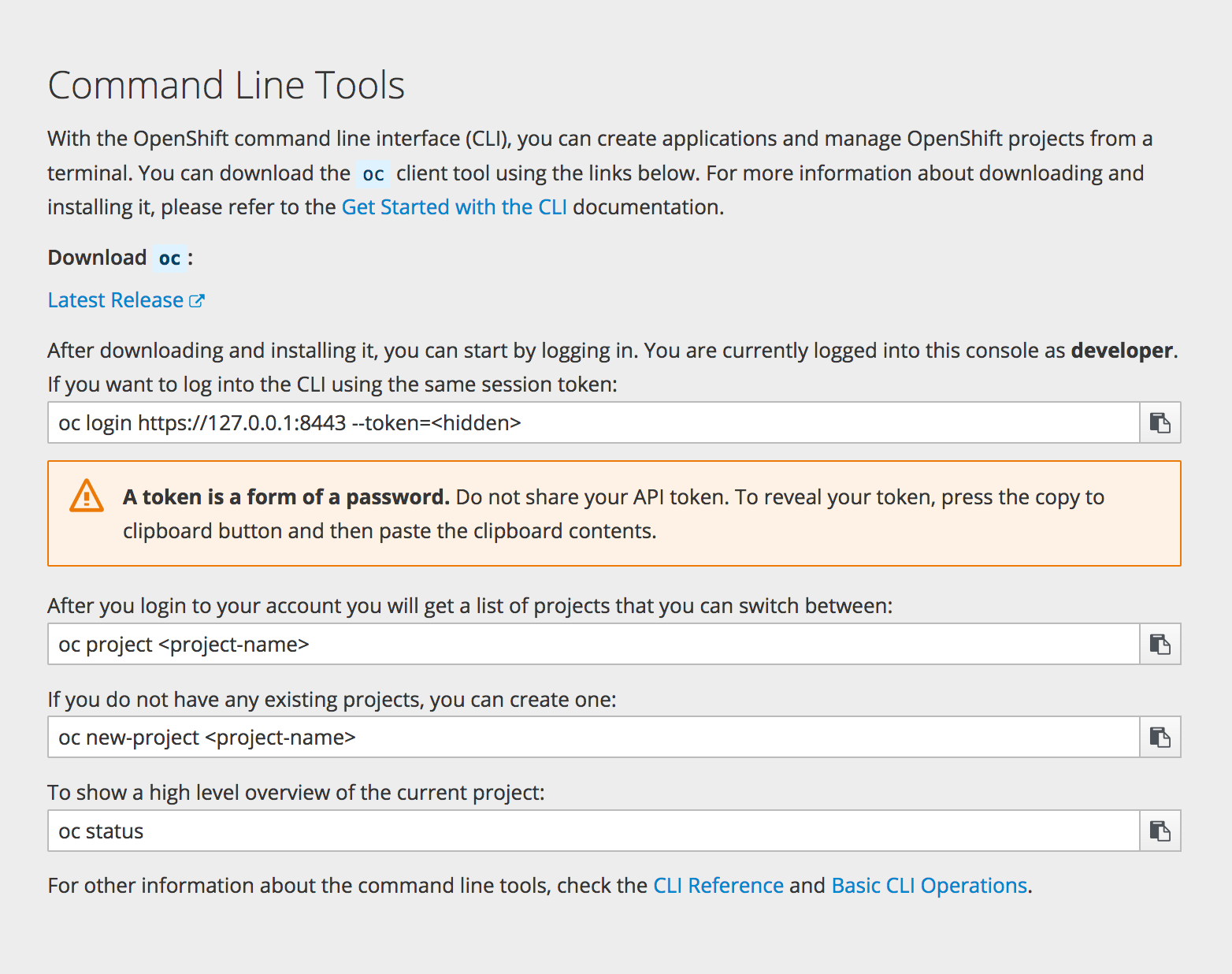

2.3.2. CLI 下载

您可从 web 控制台中的 Help 图标访问 CLI 下载:

集群管理员可以 进一步自定义这些链接。

2.3.3. 浏览器要求

查看 OpenShift Container Platform 的已测试的集成。

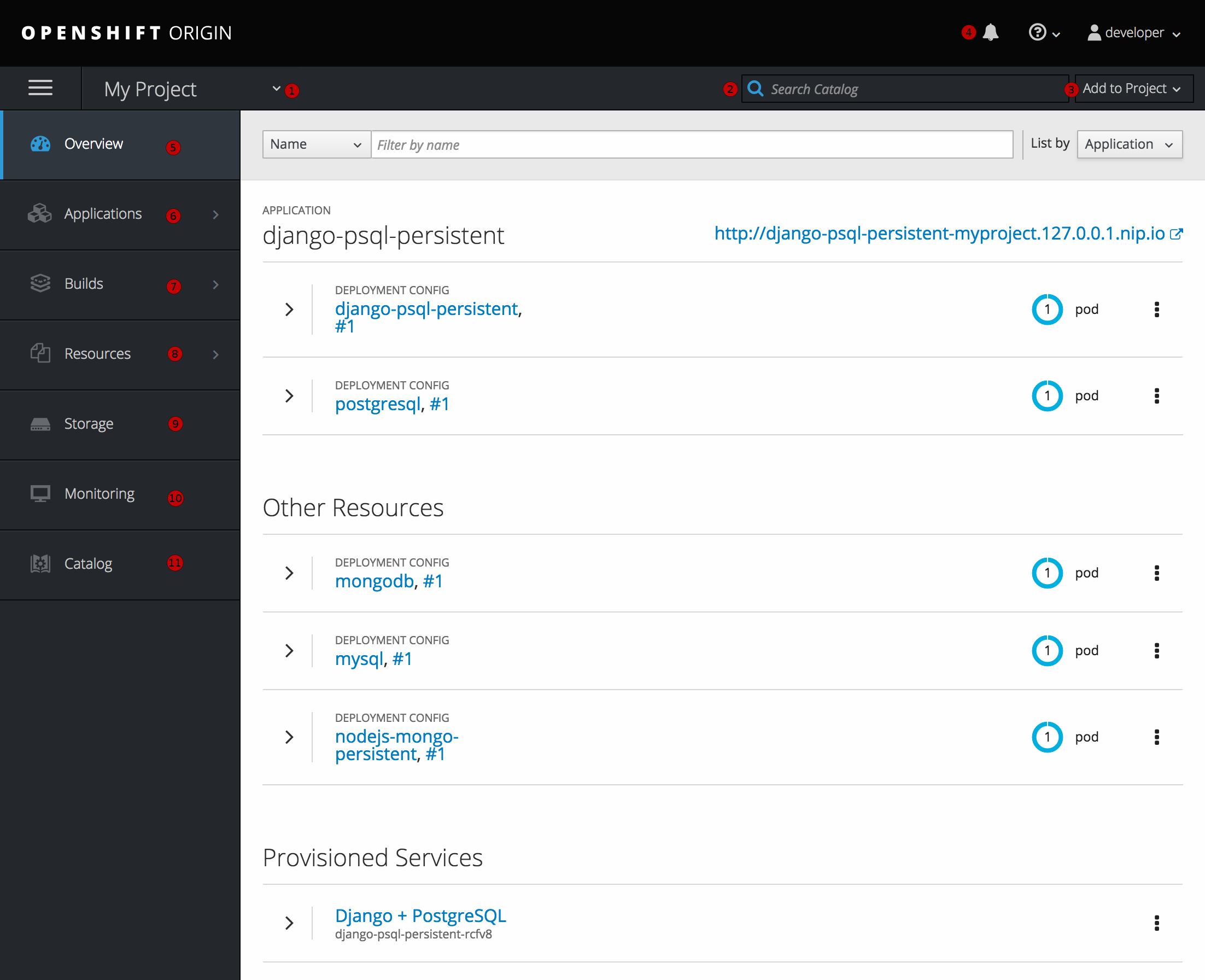

2.3.4. 项目概述

图 2.4. Web 控制台项目概述

- 通过项目选择器,您可以 切换有权访问的项目。

- 要从项目视图中快速查找服务,请输入您的搜索条件

- 使用源存储库或来自服务目录中的服务创建新应用程序。

- 与项目相关的通知。

- Overview 选项卡(当前已选中)会通过各个组件的高级视图可视化项目的内容。

- 应用程序 标签页:浏览并针对您的部署、Pod、服务和路由执行操作。

- builds 选项卡:浏览并针对您的构建和镜像流执行操作。

- resources 选项卡:查看您当前的配额消耗和其他资源。

- Storage 选项卡:查看应用程序的持久性卷声明和请求存储。

- 监控 标签页:查看构建、Pod和部署的日志,以及项目中的所有对象的事件通知。

- Catalog 选项卡:从项目内部快速获取目录。

Cockpit 会被自动安装并启用,可帮助您监控开发环境。Red Hat Enterprise Linux Atomic Host:Cockpit 入门 提供了更多有关使用 Cockpit 的信息。

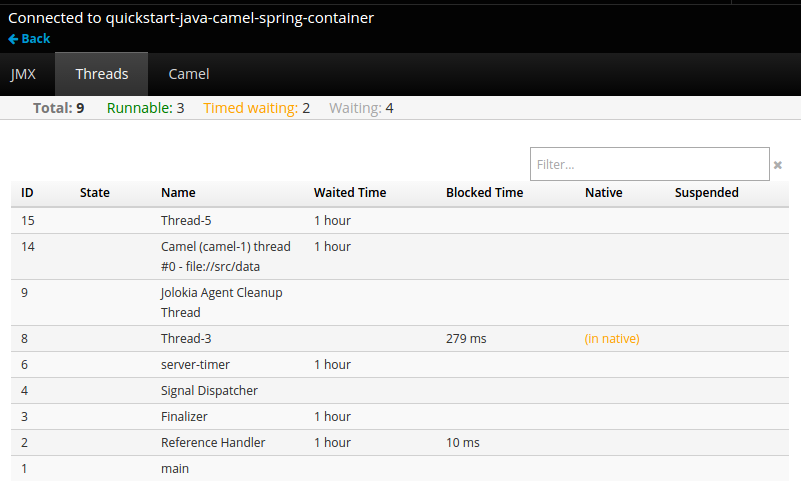

2.3.5. JVM 控制台

对于基于 Java 镜像的 pod,Web 控制台还会提供对基于 hawt.io的 JVM 控制台的访问,用于查看和管理所有相关集成组件。在 Browse → Pods 页面中的 pod 详情中会显示 Connect 链接,提供带有名为 jolokia 的端口的容器。

图 2.5. 带有到 JVM 控制台的链接的 Pod

连接 JVM 控制台后,会显示不同的页面,具体取决于哪些组件与连接的 pod 相关。

图 2.6. JVM 控制台

可用的页面如下:

| 页面 | 描述 |

|---|---|

| JMX | 查看和管理 JMX 域及 mbeans. |

| 线程 | 查看并监控线程状态。 |

| ActiveMQ | 查看和管理 Apache ActiveMQ 代理。 |

| Camel | 查看并管理 Apache Camel 路由和依赖项。 |

| OSGi | 查看并管理 JBoss Fuse OSGi 环境。 |

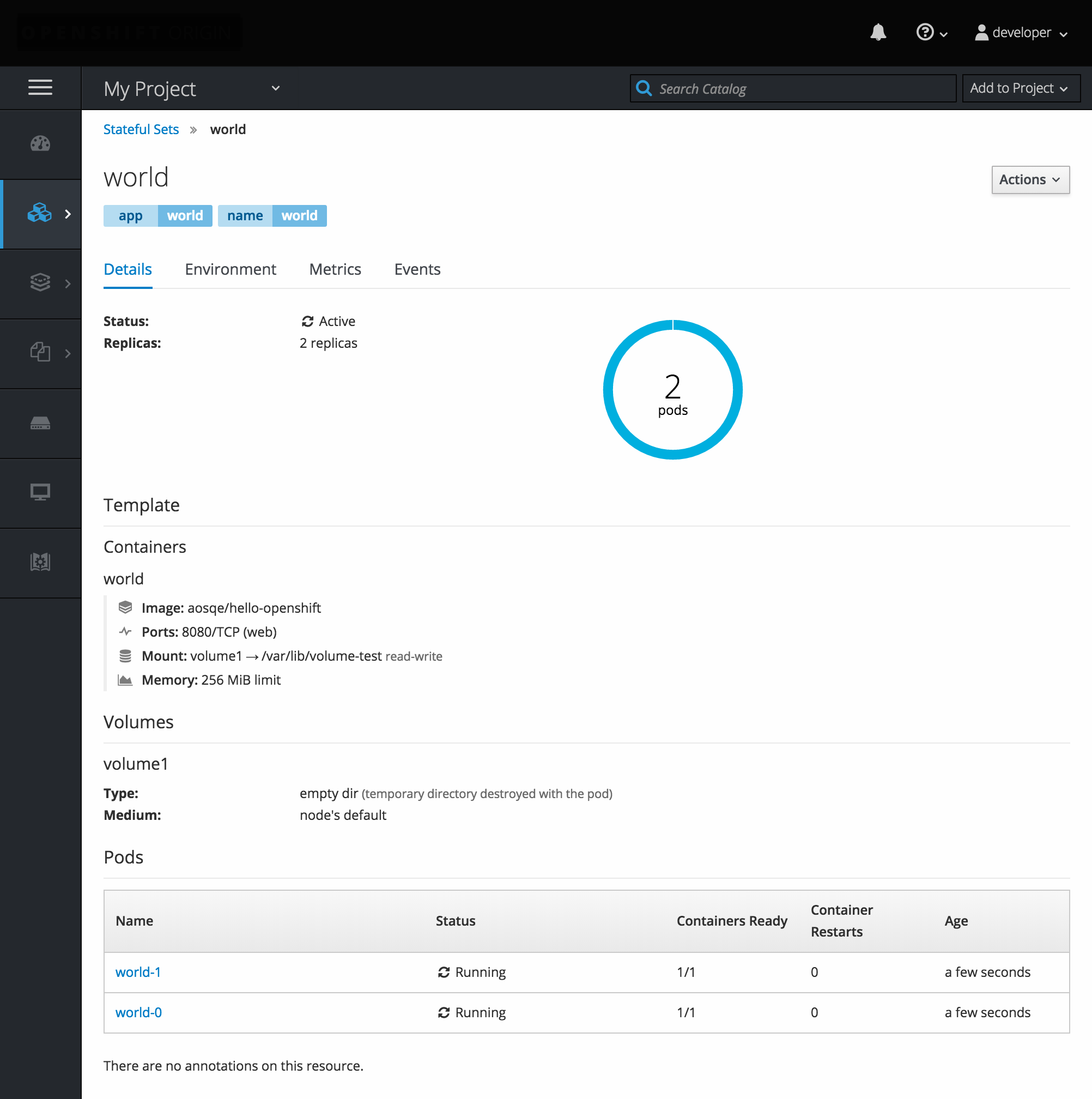

2.3.6. StatefulSets

StatefulSet 控制器为其 pod 提供唯一的身份,并确定部署和扩展顺序。StatefulSet 对于唯一标识符、持久性存储、安全部署和扩展以及安全删除和终止很有用。

图 2.7. OpenShift Container Platform 中的 StatefulSet

第 3 章 核心概念

3.1. 概述

以下主题提供有关在使用 OpenShift Container Platform 时将遇到的核心概念和对象的高级架构信息。其中许多对象来自 Kubernetes,由 OpenShift Container Platform 扩展,以提供功能丰富的开发生命周期平台。

3.2. 容器和镜像

3.2.1. 容器

OpenShift Container Platform 应用程序的基本单元称为容器。Linux 容器技术是一种轻量型机制,用于隔离运行中的进程,使它们只能跟指定的资源交互。

许多应用程序实例可以在单一主机上的容器中运行,而且相互之间看不到对方的进程、文件和网络等。通常,每个容器都提供单一服务(通常称为“微服务”),如 Web 服务器或数据库,但容器可用于任意工作负载。

多年来,Linux 内核一直在整合容器技术的能力。当前,Docker 项目为主机上的 Linux 容器开发了便捷的管理接口。OpenShift Container Platform 和 Kubernetes 添加了在多主机安装间编配 Docker 格式的容器的功能。

虽然在使用 OpenShift Container Platform 时不直接与 Docker CLI 或服务交互,但了解它们的功能和术语对于了解它们在 OpenShift Container Platform 中的角色以及您的应用程序在容器内如何工作非常重要。docker RPM 作为 RHEL 7 的一部分 7 以及 CentOS 和 Fedora 提供,因此您可以与 OpenShift Container Platform 分开进行试验。有关指南,请参阅 Red Hat 系统上的 Docker 格式化容器镜像 入门部分。

3.2.1.1. Init 容器

pod 除了应用程序容器外,pod 还可以包含 init 容器。借助初始容器,您可以重新整理设置脚本和绑定代码。init 容器与常规容器不同,容器始终运行完。每个 init 容器必须在启动下一个容器前成功完成。

如需更多信息,请参阅 Pod 和服务。

3.2.2. 镜像

OpenShift Container Platform 中的容器基于 Docker 格式的容器镜像。镜像是一种二进制文件,包含运行单一容器的所有要求以及描述其需求和功能的元数据。

您可以将其视为一种打包技术。容器只能访问其镜像中定义的资源,除非创建时授予容器其他访问权限。通过将同一镜像部署到跨越多个主机的多个容器内,并在它们之间进行负载平衡,OpenShift 容器平台可以为镜像中打包的服务提供冗余和横向扩展。

您可以直接使用 Docker CLI 构建镜像,但 OpenShift Container Platform 还提供构建器镜像,通过向现有镜像添加代码或配置来协助创建新的镜像。

由于应用程序会随时间推移开发,因此单个镜像名称实际上可以指代许多不同版本的"same"镜像。每个不同的镜像都由它的唯一哈希值引用(一个较长的十六进制数,如 fd44297e2ddb050ec4f…),通常被缩短为 12 个字符(如 fd44297e2ddb)。

镜像版本标签策略

除了版本号外,Docker 服务还允许应用标签(如 v1、 v2.1、GA 或默认 最新)来进一步指定所需的镜像,因此您可以看到同一镜像被称为 centos (表示 latest 标签)、centos:centos7 或 fd44297e2ddb。

对于任何官方 OpenShift Container Platform 镜像,不要使用 latest 标签。这些是以 openshift3/ 开头的镜像。latest 可以引用多个版本,如 3.10 或 3.11。

如何标记镜像指示更新策略。具体来说,镜像更新频率较低。使用以下项来确定您选择的 OpenShift Container Platform 镜像策略:

- vX.Y

-

vX.Y 标签指向 X.Y.Z-<number>。例如,如果

registry-console镜像更新至 v3.11,它指向最新的 3.11.Z-<number> 标签,如 3.11.1-8。 - X.Y.Z

- 与上面的 vX.Y 示例类似,X.Y.Z 标签指向最新的 X.Y.Z-<number>。例如: 3.11.1 将指向 3.11.1-8

- X.Y.Z-<number>

- 标签是唯一的,不更改。使用此标签时,如果镜像被更新,则镜像不会更新。例如,3.11.1-8 始终会指向 3.11.1-8,即使镜像被更新也是如此。

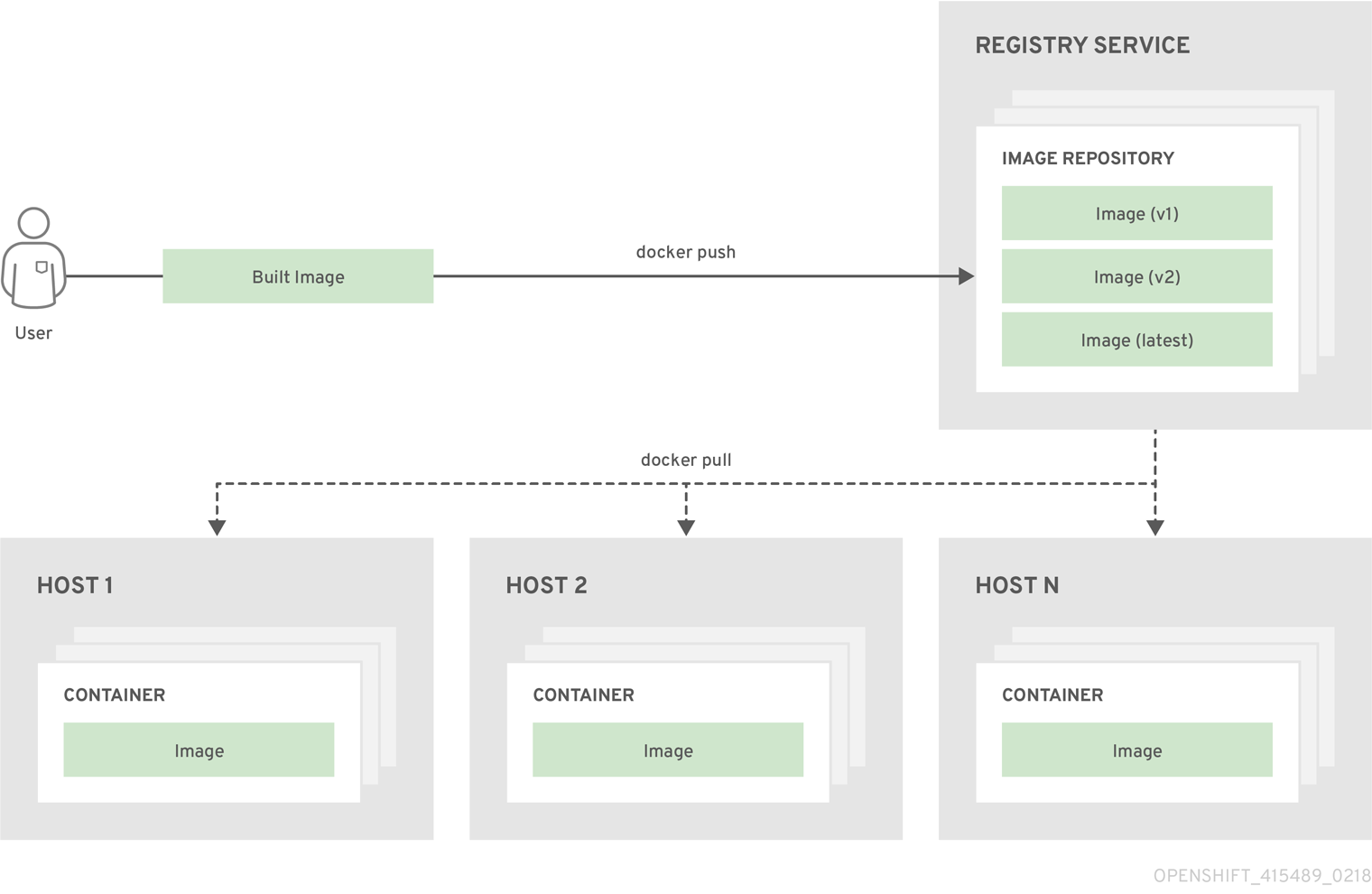

3.2.3. 容器镜像 registry

容器镜像注册表是用于存储和检索 Docker 格式的容器镜像的服务。registry 包含一个或多个镜像存储库的集合。每个镜像存储库包含一个或多个标记的镜像。Docker 提供自己的注册表,Docker Hub,您也可以使用私有或第三方注册表。红帽在 registry.redhat.io 上为订阅者提供了一个 registry。OpenShift Container Platform 还可提供其内部 registry,用于管理自定义容器镜像。

下图中描述了容器、镜像和 registry 之间的关系:

3.3. Pod 和服务

3.3.1. Pods

OpenShift Container Platform 利用 Kubernetes 的 pod 概念,它是共同部署在同一主机上的一个或多个容器,也是可被定义、部署和管理的最小计算单元。

对容器而言,Pod 大致相当于机器实例(物理或虚拟)。每个 pod 分配有自己的内部 IP 地址,因此拥有完整的端口空间,并且 pod 内的容器可以共享其本地存储和网络。

Pod 有生命周期,它们经过定义后,被分配到某一节点上运行,然后持续运行,直到容器退出或它们因为其他原因被删除为止。根据策略和退出代码,Pod 可在退出后删除,或被保留下来以启用对容器日志的访问。

OpenShift Container Platform 将 pod 基本上视为不可变;在运行期间无法更改 pod 定义。OpenShift Container Platform 通过终止现有的 pod,再利用修改后的配置和/或基础镜像重新创建 pod,从而实现更改。Pod 也被视为是可抛弃的,不会在重新创建时保持原来的状态。因此,pod 通常应由更高级别的 控制器 管理,而不是直接由用户管理。

有关每个 OpenShift Container Platform 节点主机的最大 pod 数量,请参阅集群 最大。

不受复制控制器管理的裸机 pod 不会在节点中断时重新调度。

以下是一个提供长时间运行的服务的 pod 示例定义,该服务实际上是 OpenShift Container Platform 基础架构的一部分,即集成的容器镜像 registry。它展示了 pod 的许多特性,其中大多数已在其他主题中阐述,因此这里仅简略提及:

Pod 对象定义 (YAML)

- 1

- pod 可以被“标上(tag)”一个或多个标签(label),然后使用这些标签在一个操作中选择和管理多组 pod。标签以键/值格式保存在

metadata散列中。本例中的一个标签是 docker-registry=default。 - 2

- Pod 在其命名空间内需要具有唯一名称。一个 pod 定义可以使用

generateName属性指定名称的基础,并且会自动添加随机字符来生成唯一名称。 - 3

containers指定一组容器定义;本例中只有一个,与大多时候相同。- 4

- 可以指定环境变量以将必要的值传递给每个容器。

- 5

- pod 中的每个容器使用自己的Docker 格式的容器镜像进行安装。

- 6

- 容器可绑定至在 pod 的 IP 上提供的端口。

- 7

- OpenShift Container Platform 为容器定义了一个安全上下文,指定是否允许其作为特权容器来运行,或者以所选用户身份运行,等等。默认上下文的限制性比较强,但管理员可以根据需要进行修改。

- 8

- 容器指定在容器中挂载外部存储卷的位置。在本例中,一个卷用于存储 registry 的数据,另一个卷则提供凭证的访问途径,registry 需要这些凭证来向 OpenShift Container Platform API 发出请求。

- 9

- 10

- Pod 对 OpenShift Container Platform API 发出请求是一种比较常见的模式,它有一个

serviceAccount字段,用于指定 pod 在发出请求时使用哪个服务帐户用户进行身份验证。这可以为自定义基础架构组件提供精细的访问控制。 - 11

- pod 定义了可供其容器使用的存储卷。在本例中,它提供了一个用于存储 registry 的临时卷,以及一个包含服务帐户凭证的

secret卷。

此 pod 定义不包括 OpenShift Container Platform 在 pod 创建并开始其生命周期后自动填充的属性。Kubernetes pod 文档详细介绍了 pod 的功能和用途。

3.3.1.1. Pod 重启策略

Pod 重启策略决定了 OpenShift Container Platform 在该 pod 中的容器退出时如何响应。策略应用到该 Pod 中的所有容器。

可能的值有:

-

始终 - 在pod 重启前,按指数避退延时(10s,20s,40s)持续重启 pod 上成功退出的容器。默认值为Always。 -

OnFailure- 按规定的延时值(10s,20s,40s)不断尝试重启 pod 中失败的容器,上限为 5 分钟。 -

Never- 不尝试重启 pod 中已退出或失败的容器。Pod 立即失败并退出。

绑定到节点后,pod 永远不会绑定到另一个节点。这意味着,需要一个控制器才能使 pod 在节点失败后存活:

| 状况 | 控制器类型 | 重启策略 |

|---|---|---|

| 应该终止的 Pod(例如,批量计算) |

| |

| 不应该终止的 Pod(例如,Web 服务器) |

| |

| 需要在每台机器上运行一个的 Pod | Daemonset | 任意 |

如果 pod 上的容器失败,并且重启策略被设置为 OnFailure,则 pod 会保留在该节点上并重新启动容器。如果您不希望容器重启,请使用 Never 的重启策略。

如果整个 pod 失败,OpenShift Container Platform 会启动一个新 pod。开发人员需要解决应用程序可能会在新 pod 中重启的问题。特别是,应用程序需要处理由之前运行导致的临时文件、锁定、不完整的输出等。

Kubernetes 架构需要来自云提供商的可靠端点。当云提供商停机时,kubelet 会防止 OpenShift Container Platform 重启。

如果底层云提供商端点不可靠,请不要使用云提供商集成来安装集群。应像在非云环境中一样安装集群。不建议在已安装的集群中打开或关闭云提供商集成。

如需详细了解 OpenShift Container Platform 如何使用与失败容器相关的重启策略,请参阅 Kubernetes 文档中的示例状态。

3.3.2. Init 容器

init 容器 是在 pod 应用程序容器启动前启动的 pod 中的容器。Init 容器可以共享卷,执行网络操作,并在剩余的容器启动前执行计算。Init 容器也可以阻止或延迟应用程序容器的启动,直到满足一些前提条件为止。

当 pod 启动时,在网络和卷初始化后,初始容器会按顺序启动。每个 init 容器都必须成功退出,然后调用下一个容器。如果 init 容器启动(因为运行时无法启动)或退出失败,则会根据 Pod 重启策略 来重试它。

直到所有 init 容器都成功前,pod 无法就绪。

有关一些 init 容器使用示例,请参阅 Kubernetes 文档。

以下示例概述了一个包含两个 init 容器的简单 pod。第一个 init 容器会等待 myservice,第二个则等待 mydb。两个容器都成功后,Pod 就会启动。

Init 容器 Pod 对象定义(YAML)示例

每个 init 容器都具有 app 容器的所有字段, 但 readinessProbe 除外。init 容器必须退出才能继续,且无法定义除完成之外的就绪度。

init 容器可以在 pod 上包含 activeDeadlineSeconds 和 livenessProbe,以防止 init 容器永远失败。活动截止时间包括 init 容器。

3.3.3. 服务

Kubernetes 服务 充当内部负载均衡器。它标识一组复制的 pod,以代理其接收的连接。可以在服务中任意添加或删除支持 pod,同时服务始终保持可用,从而使依赖于服务的任何对象能够以一致的地址引用它。默认服务 clusterIP 地址来自 OpenShift Container Platform 内部网络,它们用于允许 pod 相互访问。

要允许从外部访问该服务,可以将集群外部的 externalIP 和 ingressIP 地址分配给该服务。这些 externalIP 地址也可以是虚拟 IP 地址,提供对该服务 的高可用性 访问权限。

服务被分配一个 IP 地址和端口对,访问时代理到适当的后备 pod。服务使用标签选择器来查找运行的所有容器,这些容器在特定端口上提供特定的网络服务。

与 pod 一样,服务是 REST 对象。以下示例显示了上方定义的 pod 的服务定义:

服务对象定义(YAML)

Kubernetes 文档包含更多与服务相关的信息。

3.3.3.1. Service externalIPs

除了集群的内部 IP 地址外,用户还可配置集群外部的 IP 地址。管理员负责确保流量通过此 IP 到达节点。

集群管理员必须从 master-config.yaml 文件中配置的 externalIPNetworkCIDRs 范围内选择 externalIPs。当 master-config.yaml 发生更改时,必须重启 master 服务。

externalIPNetworkCIDR /etc/origin/master/master-config.yaml 示例

networkConfig: externalIPNetworkCIDRs: - 192.0.1.0.0/24

networkConfig:

externalIPNetworkCIDRs:

- 192.0.1.0.0/24服务 externalIPs 定义(JSON)

- 1

- 用于在其上公开端口的外部 IP 地址列表。此列表除了内部 IP 地址列表之外。

3.3.3.2. Service ingressIPs

在非云集群中,可以从地址池中自动分配 externalIP 地址。这可免除管理员手动分配它们的需求。

该池在 /etc/origin/master/master-config.yaml 文件中进行配置。更改此文件后,重启 master 服务。

ingressIPNetworkCIDR 被默认设置为 172.29.0.0/16。如果集群环境还没有使用这个私有范围,请使用默认范围或设置自定义范围。

如果您使用高可用性,则此范围必须小于 256 个地址。

ingressIPNetworkCIDR /etc/origin/master/master-config.yaml 示例

networkConfig: ingressIPNetworkCIDR: 172.29.0.0/16

networkConfig:

ingressIPNetworkCIDR: 172.29.0.0/163.3.3.3. Service NodePort

设置服务 type=NodePort 将从错误配置的范围分配一个端口(默认):30000-32767,每个节点会将端口(每个节点中的相同端口号)代理到您的服务中。

所选端口将在服务配置中报告,位于 spec.ports[*].nodePort 下。

要指定一个自定义端口,可将端口号放在 nodePort 字段中。自定义端口号必须在为 nodePorts 配置范围内。当 'master-config.yaml' 被改变时,必须重启 master 服务。

Sample servicesNodePortRange /etc/origin/master/master-config.yaml

kubernetesMasterConfig: servicesNodePortRange: ""

kubernetesMasterConfig:

servicesNodePortRange: ""

该服务将同时作为 < NodeIP>:spec.ports[].nodePort 和 spec.clusterIp:spec.ports[].port的形式可见

设置 nodePort 是一个特权操作。

3.3.3.4. 服务代理模式

OpenShift Container Platform 有两个不同实现的服务路由基础架构。默认的实现完全基于 iptables,并使用 probabilistic iptables 重新编写规则以在端点 Pod 之间分发传入的服务连接。较早的实施使用用户空间进程接受进入的连接,然后在客户端和其中一个端点 Pod 之间代理流量。

基于 iptables的实施效率更高,但它要求所有端点始终能够接受连接;用户空间实施的速度较慢,但可以依次尝试多个端点,直到找到可正常工作。如果您有良好的 就绪度检查 (或通常可靠的节点和 pod),则基于 iptables的服务代理是最佳选择。否则,您可以在安装时或通过编辑节点配置文件在部署集群时启用基于用户空间的代理。

3.3.3.5. 无头服务

如果您的应用程序不需要负载均衡或单一服务 IP 地址,您可以创建一个无头服务。当您创建无头服务时,不会执行负载均衡或代理,也不会为该服务分配集群 IP。对于此类服务,DNS 会根据服务是否定义了选择器来自动配置。

使用选择器的服务 :对于定义选择器的无头服务,端点控制器会在 API 中创建 Endpoints 记录,并修改 DNS 配置来返回指向支持该服务的 pod 的 A 记录(地址)。

没有选择器的服务 :对于不定义选择器的无头服务,端点控制器不会创建 端点 记录。但是,DNS 系统会查找并配置以下记录:

-

对于

ExternalName类型服务,为CNAME记录。 -

对于所有其他服务类型,对于与服务共享名称的任何端点的

记录。

3.3.3.5.1. 创建无头服务

创建无头服务与创建标准服务类似,但不会声明 ClusterIP 地址。要创建无头服务,请添加 clusterIP:none 参数值为服务 YAML 定义。

例如,对于您要成为同一集群或服务一部分的 pod 组。

Pod 列表

oc get pods -o wide

$ oc get pods -o wide输出示例

NAME READY STATUS RESTARTS AGE IP NODE frontend-1-287hw 1/1 Running 0 7m 172.17.0.3 node_1 frontend-1-68km5 1/1 Running 0 7m 172.17.0.6 node_1

NAME READY STATUS RESTARTS AGE IP NODE

frontend-1-287hw 1/1 Running 0 7m 172.17.0.3 node_1

frontend-1-68km5 1/1 Running 0 7m 172.17.0.6 node_1您可以将无头服务定义为:

无头服务定义

另外,无头服务本身没有任何 IP 地址。

oc get svc

$ oc get svc输出示例

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE frontend ClusterIP 172.30.232.77 <none> 5432/TCP 12m frontend-headless ClusterIP None <none> 5432/TCP 10m

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

frontend ClusterIP 172.30.232.77 <none> 5432/TCP 12m

frontend-headless ClusterIP None <none> 5432/TCP 10m3.3.3.5.2. 使用无头服务进行端点发现

使用无头服务的好处是您可以直接发现 pod 的 IP 地址。标准服务充当负载均衡器或代理,并使用服务名称来提供对工作负载对象的访问。使用无头服务时,服务名称将解析为服务分组的 pod 的 IP 地址集合。

当您查找标准服务的 DNS A 记录时,您将获得服务的负载均衡 IP。

dig frontend.test A +search +short

$ dig frontend.test A +search +short输出示例

172.30.232.77

172.30.232.77但是,对于无头服务,您可以获取单个 pod 的 IP 列表。

dig frontend-headless.test A +search +short

$ dig frontend-headless.test A +search +short输出示例

172.17.0.3 172.17.0.6

172.17.0.3

172.17.0.6

对于使用带有 StatefulSet 的无头服务以及相关的用例,您需要在初始化和终止期间解析 pod 的 DNS,将 publishNotReadyAddresses 设置为 true (默认值为 false)。当 publishNotReadyAddresses 设为 true 时,这表示 DNS 实现必须发布与该服务关联的 Endpoints 子集的 notReadyAddresses。

3.3.4. 标签

标签用于组织、组或选择 API 对象。例如,pod 使用标签进行"标记",服务使用标签选择器标识其代理的 pod。这使得服务能够引用 pod 组,甚至可以将带有不同容器的 pod 视为相关的实体。

大多数对象都可以在其元数据中包含标签。因此标签可用于对特定应用程序的不同对象进行分组,例如,所有 pod、服务、复制控制器 和 部署配置 都可以分组。

标签是简单的键/值对,如下例所示:

labels: key1: value1 key2: value2

labels:

key1: value1

key2: value2考虑:

- 由 nginx 容器组成的 Pod,标签为 role=webserver。

- 由 Apache httpd 容器组成的 pod,其标签为 role=webserver。

定义为使用 role=webserver 标签的 pod 的服务或复制控制器会将这两个 pod 视为同一组的一部分。

Kubernetes 文档包含有关标签的更多信息。

3.3.5. Endpoints

后端服务的服务器称为其端点,并由名称与服务同名的 Endpoints 类型的对象指定。当服务由 pod 支持时,这些 pod 通常由服务规格中的标签选择器指定,OpenShift Container Platform 会自动创建指向这些 pod 的 Endpoints 对象。

在某些情况下,您可能想要创建服务,但它由外部主机支持,而不是由 OpenShift Container Platform 集群中的 pod 支持。在这种情况下,您可以取消服务中的 selector 字段,并 手动创建 Endpoints 对象。

请注意,OpenShift Container Platform 不允许大多数用户手动创建端点对象,指向为 pod 和服务 IP 保留的网络块中的 IP 地址。只有集群管理员或其他有权在 端点/限制 创建此类 Endpoint 对象。

下创建 资源的用户才能

3.4. 项目和用户

3.4.1. 用户

与 OpenShift Container Platform 的交互与用户相关联。OpenShift Container Platform 用户对象代表一个执行者,可以通过向 它们或组 添加角色来授予 系统中的权限。

可能存在的用户类型有几种:

| 常规用户 |

这是大多数交互式 OpenShift Container Platform 用户表示的方式。常规用户在第一次登录时在系统中自动创建,或者通过 API 创建。常规用户通过 |

| 系统用户 |

许多系统用户在基础架构定义时自动创建,主要用于使基础架构与 API 安全地交互。这包括集群管理员(有权访问一切资源)、特定于一个节点的用户、供路由器和 registry 使用的用户,以及一些其他用户。最后,有一个 |

| 服务帐户 |

这些是与项目关联的特殊系统用户;其中一些在项目首次创建时自动创建,而项目管理员可以创建更多服务帐户来定义对各个项目的内容的访问权限。服务帐户通过 |

每一用户必须通过 某种形式的身份验证才能访问 OpenShift Container Platform。无身份验证或身份验证无效的 API 请求会被验证为由 匿名系统用户 发出的请求。经过身份验证后,策略决定用户 被授权执行的操作。

3.4.2. 命名空间

Kubernetes 命名空间提供范围集群中资源的机制。在 OpenShift Container Platform 中,项目 是一个带有额外注解的 Kubernetes 命名空间。

命名空间为以下对象提供唯一范围:

- 指定名称的资源,以避免基本命名冲突。

- 委派给可信用户的管理授权。

- 限制社区资源消耗的能力。

系统中的大多数对象都通过命名空间来设定范围,但一些对象不在此列且没有命名空间,如节点和用户。

Kubernetes 文档中提供有关命名空间的更多信息。

3.4.3. 项目

项目是附带额外注解的 Kubernetes 命名空间,是管理常规用户资源访问权限的中央载体。通过项目,一个社区的用户可以在与其他社区隔离的前提下组织和管理其内容。用户必须由管理员授予对项目的访问权限;或者,如果用户有权创建项目,则自动具有自己创建项目的访问权限。

项目可以有单独的 name, displayName, 和 description。

-

必需的

name是项目的唯一标识符,在使用 CLI 工具或 API 时是做常用的。名称长度最多为 63 个字符。 -

可选的

displayName是项目在 web 控制台中的显示形式(默认为name)。 -

可选的描述可以是项目更为详细的描述,它也在 Web 控制台中可见。

每个项目限制了自己的一组:

| 对象(object) | Pod、服务和复制控制器等。 |

| 策略(policy) | 用户能否对对象执行操作的规则。 |

| 约束(constraint) | 对各种对象进行限制的配额。 |

| 服务帐户 | 服务帐户自动使用项目中对象的指定访问权限进行操作。 |

集群管理员可以 创建项目,并将项目 的管理权限委派给 用户社区的任何成员。集群管理员也可以允许开发人员 创建自己的项目。

开发人员和管理员可以使用 CLI 或 Web 控制台 与项目交互。

3.4.3.1. 安装时提供的项目

OpenShift Container Platform 附带大量项目,以 openshift- 开头的项目对用户来说最为重要。这些项目托管作为 Pod 运行的主要组件和其他基础架构组件。在这些命名空间中创建的带有 关键 Pod 注解的 pod 被视为关键,它们会保证被 kubelet 准入。在这些命名空间中为主要组件创建的 Pod 已标记为“critical”。

3.5. 构建和镜像流

3.5.1. 构建(build)

构建 (build)是将输入参数转换为结果对象的过程。此过程最常用于将输入参数或源代码转换为可运行的镜像。BuildConfig 对象是整个构建过程的定义。

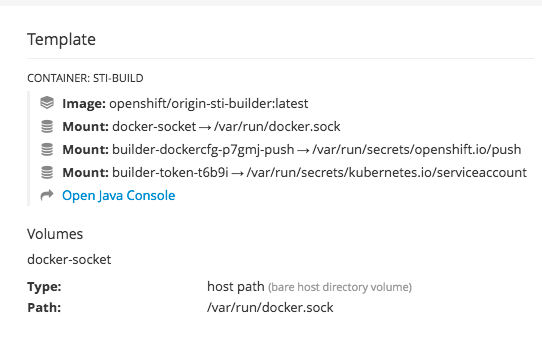

OpenShift Container Platform 通过从构建镜像创建 Docker 格式的容器,并将它们推送到 容器镜像 registry 中。

构建对象共享共同特征:构建的输入、完成构建过程需要、记录构建过程、从成功构建中发布资源并发布构建的最终状态。构建会使用资源限制,具体是指定资源限值,如 CPU 使用量、内存使用量,以及构建或 Pod 执行时间。

OpenShift Container Platform 构建系统提供对构建策略的可扩展支持,它们基于构建 API 中指定的可选择类型。可用的构建策略主要有三种:

默认情况下,支持 Docker 构建和 S2I 构建。

构建生成的对象取决于用于创建它的构建器(builder)。对于 Docker 和 S2I 构建,生成的对象为可运行的镜像。对于 Custom 构建,生成的对象是构建器镜像作者指定的任何事物。

另外,也可利用 Pipeline 构建策略来实现复杂的工作流:

- 持续集成

- 持续部署

有关构建命令列表,请参阅开发人员指南。

如需有关 OpenShift Container Platform 如何使用 Docker 进行构建的更多信息,请参阅上游文档。

3.5.1.1. Docker 构建

Docker 构建策略调用 docker build 命令,因此需要一个含有 Dockerfile 的存储库并且其中包含所有必要的工件,从而能生成可运行的镜像。

3.5.1.2. Source-to-Image(S2I)构建

Source-to-Image(S2I) 是一种用于构建可重复生成的 Docker 格式容器镜像的工具。它通过将应用程序源代码注入容器镜像并汇编新镜像来生成可随时运行的镜像。新镜像融合了基础镜像(构建器)和构建的源代码,并可搭配 docker run 命令使用。S2I 支持递增构建,可重复利用以前下载的依赖项和过去构建的工件等。

S2I 的优点包括:

| 镜像灵活性 |

可以编写 S2I 脚本,将应用程序代码注入到几乎所有现有的 Docker 格式容器镜像,以此利用现有的生态系统。请注意,S2I 目前依靠 |

| 速度 | 使用 S2I 时,汇编过程可以执行大量复杂操作,无需在每一步创建新层,进而能实现快速的流程。此外,可以编写 S2I 脚本来重复利用应用程序镜像的旧版本,而不必在每次运行构建时下载或构建它们。 |

| 可修补性 | 如果基础镜像因为安全问题而需要补丁,则 S2I 允许基于新的基础镜像重新构建应用程序。 |

| 操作效率 | 通过限制构建操作而不许随意进行 Dockerfile 允许的操作,PaaS 运维人员可以避免意外或故意滥用构建系统。 |

| 操作安全性 | 构建任意 Dockerfile 会将主机系统暴露于 root 特权提升。因为整个 Docker 构建过程都通过具备 Docker 特权的用户运行,这可能被恶意用户利用。S2I 限制以 root 用户执行操作,而能够以非 root 用户运行脚本。 |

| 用户效率 |

S2I 禁止开发人员在应用程序构建期间执行任意 |

| 生态系统 | S2I 倡导共享镜像生态系统,您可以将其中的最佳实践运用于自己的应用程序。 |

| 可重复生成性 | 生成的镜像可以包含所有输入,包括构建工具和依赖项的特定版本。这可确保精确地重新生成镜像。 |

3.5.1.3. 自定义构建

采用 Custom 构建策略时,开发人员可以定义负责整个构建过程的特定构建器镜像。通过利用自己的构建器镜像,可以自定义构建流程。

自定义构建器(Custom builder)镜像是嵌入了构建过程逻辑的普通 Docker 格式容器镜像,例如用于构建 RPM 或基础镜像。openshift/origin-custom-docker-builder 镜像在 Docker Hub registry 上作为自定义构建器镜像的示例实施提供。

3.5.1.4. Pipeline 构建

采用 Pipeline 构建策略时,开发人员可以定义 Jenkins Pipeline 由 Jenkins Pipeline 插件执行。构建可以由 OpenShift Container Platform 启动、监控和管理,其方式与任何其他构建类型相同。

Pipeline 工作流在 Jenkinsfile 中定义,或直接嵌入在构建配置中,或者在 Git 存储库中提供并由构建配置引用。

项目第一次使用 Pipeline 策略定义构建配置时,OpenShift Container Platform 会实例化 Jenkins 服务器来执行管道。项目中的后续管道构建配置将共享这个 Jenkins 服务器。

有关如何部署 Jenkins 服务器以及如何配置或禁用自动置备行为的详情,请参阅配置管道执行。

即使所有 Pipeline 构建配置都被删除,Jenkins 服务器也不会自动删除。用户必须手动删除它。

有关 Jenkins Pipelines 的更多信息,请参阅 Jenkins 文档。

3.5.2. 镜像流

镜像流及其关联标签提供了一个用于从 OpenShift Container Platform 中引用容器镜像的抽象 集。镜像流及其标签用于查看可用镜像,确保您使用所需的特定镜像,即使存储库中的镜像发生变化也是如此。

镜像流不含实际镜像数据,它提供了相关镜像的一个单独的虚拟视图,类似于镜像存储库。

您可以在添加新镜像时,配置构建和部署来监控镜像流的通知,并通过分别执行构建或部署来做出反应。

例如,如果部署正在使用某个镜像并且创建了该镜像的新版本,则会自动执行部署以获取镜像的新版本。

但是,如果没有更新 Deployment 或 Build 使用的镜像流标签,则即使更新了容器镜像 registry 中的容器镜像,构建或部署仍会继续使用之前的(已知良好)镜像。

源镜像可存储在以下任一位置:

- OpenShift Container Platform 集成的 registry

-

一个外部 registry,如

registry.redhat.io或hub.docker.com - OpenShift Container Platform 集群中的其他镜像流

当您定义引用镜像流标签(如构建或部署配置)的对象时,您指向镜像流标签,而不是 Docker 存储库。当您构建或部署应用程序时,OpenShift Container Platform 会使用镜像流标签查询 Docker 存储库,以查找与镜像关联的 ID,并使用正确的镜像。

镜像流元数据会与其他集群信息一起存储在 etcd 实例中。

以下镜像流包含两个标签:34 个指向 Python v3.4 镜像和 35 (指向 Python v3.5 镜像)的 34:

oc describe is python

$ oc describe is python输出示例

使用镜像流有以下几大优势:

- 您可以添加标签、回滚标签和快速处理镜像,而无需使用命令行重新执行 push 操作。

- 当一个新镜像被推送(push)到 registry 时,可触发构建和部署。另外,OpenShift Container Platform 还针对其他资源(如 Kubernetes 对象)具有通用触发器。

- 您可以为定期重新导入标记标签。如果源镜像已更改,则这个更改会被发现并反映在镜像流中,这会触发构建和/或部署流程,具体取决于构建或部署配置。

- 您可使用细粒度访问控制来共享镜像,快速向整个团队分发镜像。

- 如果源更改,镜像流标签仍将指向已知良好的镜像版本,以确保您的应用程序不会意外中断。

- 您可以通过 镜像流对象 的权限配置安全性,以了解谁可以查看和使用镜像。

- 在集群级别上缺少读取或列出镜像权限的用户仍可使用镜像流来检索项目中标记的镜像。

有关策展的镜像流集合,请参阅 OpenShift 镜像流和模板库。

使用镜像流时,务必要了解镜像流标签指向什么以及如何对标签和镜像的更改产生影响。例如:

-

如果您的镜像流标签指向容器镜像标签,则需要了解如何更新容器镜像标签。例如,容器镜像标签

docker.io/ruby:2.5指向 v2.5 ruby 镜像,但容器镜像标签docker.io/ruby:latest更改有主要版本。因此,镜像流标签所指向的容器镜像标签可以告诉您镜像流标签的稳定程度。 - 如果您的镜像流标签跟随另一个镜像流标签,而不是直接指向容器镜像标签,那么镜像流标签可能会更新,以便在以后遵循不同的镜像流标签。这个更改可能会导致获取不兼容的版本更改。

3.5.2.1. 重要术语

- Docker 软件仓库

相关容器镜像和标识它们的标签的集合。例如,OpenShift Jenkins 镜像位于 Docker 存储库中:

docker.io/openshift/jenkins-2-centos7

docker.io/openshift/jenkins-2-centos7Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 容器 registry

可以从 Docker 存储库存储和服务镜像的内容服务器。例如:

registry.redhat.io

registry.redhat.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 容器镜像

- 可以作为容器运行的特定一组内容。通常与 Docker 存储库中的特定标签关联。

- 容器镜像标签

- 应用到存储库中容器镜像的标签,用于区分特定镜像。例如,这里 3.6.0 是一个标签:

docker.io/openshift/jenkins-2-centos7:3.6.0

docker.io/openshift/jenkins-2-centos7:3.6.0可以更新容器镜像标签,以便可以随时指向新的容器镜像内容。

- 容器镜像 ID

- 可用于拉取镜像的 SHA(安全哈希算法)代码。例如:

docker.io/openshift/jenkins-2-centos7@sha256:ab312bda324

docker.io/openshift/jenkins-2-centos7@sha256:ab312bda324SHA 镜像 ID 不能更改。特定 SHA 标识符会始终引用完全相同的容器镜像内容。

- 镜像流

- 一个 OpenShift Container Platform 对象,其中包含指向由标签识别的任意数量的 Docker 格式容器镜像的指针。您可以将镜像流视为等同于 Docker 存储库。

- 镜像流标签

- 指向镜像流中镜像的命名指针。镜像流标签与容器镜像标签类似。请参阅以下镜像流标签。

- 镜像流镜像

- 允许您从标记了特定容器镜像的特定镜像流中检索该镜像。镜像流镜像是一个 API 资源对象,用于收集一些有关特定镜像 SHA 标识符的元数据。请参阅以下镜像流镜像。

- 镜像流触发器

- 当镜像流标签更改时引发特定操作的触发器。例如,导入可导致标签值变化。当有部署、构建或其他资源监听这些信息时,就会启动触发器。请参阅以下镜像流触发器。

3.5.2.2. 配置镜像流

镜像流对象文件包含以下元素。

有关管理镜像和镜像流的详细信息,请参阅 开发人员指南。

镜像流对象定义

有关引用镜像流的示例构建配置,请参阅配置的 Strategy 小节中的 BuildConfig? 是什么。

有关引用镜像流的示例部署配置,请参阅在配置的 Strategy 部分中创建部署配置。

3.5.2.3. 镜像流镜像

一个镜像流镜像会从一个镜像流内指向一个特定的镜像 ID。

镜像流镜像允许您从标记了镜像的特定镜像流中检索有关镜像的元数据。

每当您将镜像导入或标记到镜像流时,OpenShift Container Platform 中会自动创建镜像流镜像对象。您不必在用于创建镜像流的任何镜像流定义中显式定义镜像流镜像对象。

镜像流镜像包含来自存储库的镜像流名称和镜像 ID,用 @ 符号分隔:

<image-stream-name>@<image-id>

<image-stream-name>@<image-id>要引用 上面的镜像流对象示例中的镜像,镜像流镜像类似如下:

origin-ruby-sample@sha256:47463d94eb5c049b2d23b03a9530bf944f8f967a0fe79147dd6b9135bf7dd13d

origin-ruby-sample@sha256:47463d94eb5c049b2d23b03a9530bf944f8f967a0fe79147dd6b9135bf7dd13d3.5.2.4. 镜像流标签

镜像流标签是指向镜像流中的一个镜像的命名指针。通常缩写为 istag。镜像流标签用于引用或检索给定镜像流和标签的镜像。

镜像流标签可引用任何本地管理或外部管理的镜像。它包含镜像历史记录,表示为标签曾指向的所有镜像的堆栈。每当特定镜像流标签下标记了新的或现有镜像时,该镜像将置于历史记录堆栈的第一位置。之前占据第一位置的镜像将移至第二位置,以此类推。这样便于回滚,从而让标签再次指向历史镜像。

以下镜像流标签来自 上面的 镜像流标签 :

历史记录中带有两个镜像的镜像流标签

镜像流标签可以是 持久性标签,也可以是 跟踪标签。

- 持久性标签是特定于版本的标签,指向镜像的特定版本,如 Python 3.5。

跟踪标签是引用 标签,跟随另一个镜像流标签,并在以后更新以更改它们跟随的镜像,这与符号链接非常相似。请注意,这些新等级无法保证向后兼容。

例如,OpenShift Container Platform 附带的

latest镜像流标签是跟踪标签。这意味着,当有新级别可用时,latest镜像流标签的用户会更新为镜像提供的最新框架级别。指向v3.10的latest镜像流标签可以随时更改为v3.11。请务必注意,这些latest镜像流标签的行为与 Dockerlatest标签不同。在本例中,latest镜像流标签不指向 Docker 存储库中的最新镜像。它指向另一个镜像流标签,可能并非镜像的最新版本。例如,如果latest镜像流标签指向v3.10镜像,则当发布了3.11版时,latest标签不会自动更新至v3.11,并保持v3.10,直到手动更新为指向v3.11镜像流标签。注意跟踪标签仅限于单个镜像流,无法引用其他镜像流。

您可以根据自己的需要创建自己的镜像流标签。请参阅 推荐标记。

镜像流标签由镜像流名称和一个标签组成,用冒号隔开:

<image stream name>:<tag>

<image stream name>:<tag>

例如,要引用 上面的 镜像流对象示例中的 sha256:47463d94eb5c049b2d23b03a9530bf944f8f967a0fe79147dd6b9135bf7dd13d 镜像,镜像流标签将是:

origin-ruby-sample:latest

origin-ruby-sample:latest3.5.2.5. 镜像流更改触发器

当有新版本上游镜像时,镜像流触发器支持自动调用构建和部署。

例如,修改镜像流标签时,构建和部署可以自动启动。实现方法是通过监控特定镜像流标签并在检测到变化时通知构建或部署。

ImageChange 触发器会在镜像流标签内容更改时( 推送镜像的新版本时 )产生新的复制控制器。

ImageChange 触发器

- 1

- 如果

imageChangeParams.automatic字段设置为false,则触发器被禁用。

在上例中,当 origin-ruby-sample 镜像流的 latest 标签值更改并且新镜像值与部署配置的 helloworld 容器中指定的当前镜像不同时,会使用 helloworld 容器的新镜像创建新的复制控制器。

如果在部署配置上定义了 ImageChange 触发器(带有 ConfigChange 触发器和 automatic=false,或者 automatic=true)并且 ImageChange 触发器指向的 ImageStreamTag 尚不存在,则初始部署过程将在镜像导入时或由构建推送到 ImageStreamTag 时立即自动启动。

3.5.2.6. 镜像流映射

当 集成的 registry 收到新镜像时,它会创建镜像流映射并将其发送到 OpenShift Container Platform,从而提供镜像的项目、名称、标签和镜像元数据。

配置镜像流映射是高级功能。

此信息用于创建新镜像(如果尚未存在)并将此镜像标记到镜像流中。OpenShift Container Platform 存储每个镜像的完整元数据,如命令、入口点和环境变量。OpenShift Container Platform 中的镜像不可变,名称最长 63 个字符。

有关手动标记镜像的详情,请参阅 Developer Guide。

以下镜像流映射示例结果是将镜像标记为 test/origin-ruby-sample:latest:

镜像流映射对象定义

3.5.2.7. 使用镜像流

以下小节介绍了如何使用镜像流和镜像流标签。有关使用镜像流的更多信息,请参阅管理镜像。

3.5.2.7.1. 获取有关镜像流的信息

要获取有关镜像流的常规信息及其指向的所有标签的详细信息,请使用以下命令:

oc describe is/<image-name>

$ oc describe is/<image-name>例如:

oc describe is/python

$ oc describe is/python输出示例

要获取有关特定镜像流标签的所有可用信息:

oc describe istag/<image-stream>:<tag-name>

$ oc describe istag/<image-stream>:<tag-name>例如:

oc describe istag/python:latest

$ oc describe istag/python:latest输出示例

输出的信息多于显示的信息。

3.5.2.7.2. 在镜像流中添加额外标签

要添加指向其中一个现有标签的标签,您可以使用 oc tag 命令:

oc tag <image-name:tag> <image-name:tag>

oc tag <image-name:tag> <image-name:tag>例如:

oc tag python:3.5 python:latest

$ oc tag python:3.5 python:latest输出示例

Tag python:latest set to python@sha256:49c18358df82f4577386404991c51a9559f243e0b1bdc366df25.

Tag python:latest set to python@sha256:49c18358df82f4577386404991c51a9559f243e0b1bdc366df25.

使用 oc describe 命令确认镜像流有两个标签,一个(3.5)指向外部容器镜像,另一个标签(latest)指向同一镜像,因为它基于第一个标签创建。

oc describe is/python

$ oc describe is/python输出示例

3.5.2.7.3. 为外部镜像添加标签

对所有标签相关的操作使用 oc tag 命令,如添加标签指向内部或外部镜像:

oc tag <repositiory/image> <image-name:tag>

$ oc tag <repositiory/image> <image-name:tag>

例如,该命令可将 docker.io/python:3.6.0 镜像映射到 python 镜像流中的 3.6 标签。

oc tag docker.io/python:3.6.0 python:3.6

$ oc tag docker.io/python:3.6.0 python:3.6输出示例

Tag python:3.6 set to docker.io/python:3.6.0.

Tag python:3.6 set to docker.io/python:3.6.0.如果外部镜像安全,则需要创建带有用于访问该 registry 的凭证的 secret。如需了解更多详细信息,请参阅从私有 registry 中导入镜像。

3.5.2.7.4. 更新镜像流标签

要更新标签以反映镜像流中的另一标签:

oc tag <image-name:tag> <image-name:latest>

$ oc tag <image-name:tag> <image-name:latest>

例如,以下命令更新了 latest 标签,以反映镜像流中的 3.6 标签:

oc tag python:3.6 python:latest

$ oc tag python:3.6 python:latest输出示例

Tag python:latest set to python@sha256:438208801c4806548460b27bd1fbcb7bb188273d13871ab43f.

Tag python:latest set to python@sha256:438208801c4806548460b27bd1fbcb7bb188273d13871ab43f.3.5.2.7.5. 从镜像流中删除镜像流标签

从镜像流中删除旧标签:

oc tag -d <image-name:tag>

$ oc tag -d <image-name:tag>例如:

oc tag -d python:3.5

$ oc tag -d python:3.5输出示例

Deleted tag default/python:3.5.

Deleted tag default/python:3.5.3.5.2.7.6. 配置标签定期导入

使用外部容器镜像 registry 时,要定期重新导入镜像(例如,获取最新的安全更新),请使用 --scheduled 标志:

oc tag <repositiory/image> <image-name:tag> --scheduled

$ oc tag <repositiory/image> <image-name:tag> --scheduled例如:

oc tag docker.io/python:3.6.0 python:3.6 --scheduled

$ oc tag docker.io/python:3.6.0 python:3.6 --scheduled输出示例

Tag python:3.6 set to import docker.io/python:3.6.0 periodically.

Tag python:3.6 set to import docker.io/python:3.6.0 periodically.该命令可使 OpenShift Container Platform 定期更新该特定镜像流标签。此周期是集群范围的设置,默认设为 15 分钟。

要删除定期检查,请重新运行上述命令,但省略 --scheduled 标志。这会将其行为重置为默认值。

oc tag <repositiory/image> <image-name:tag>

$ oc tag <repositiory/image> <image-name:tag>3.6. Deployments

3.6.1. 复制控制器

复制控制器确保任何时候都运行指定数量的 pod 副本。如果 pod 退出或被删除,复制控制器会做出反应,实例化更多 pod 来达到定义的数量。同样,如果运行中的数量超过所需的数目,它会根据需要删除相应数量的 Pod,使其与定义的数量相符。

复制控制器配置包括:

- 所需的副本数(可在运行时调整)。

- 创建复制容器集时要使用的容器集定义。

- 用于标识受管 pod 的选择器。

选择器是分配给由复制控制器管理的 pod 的一组标签。这些标签包含在复制控制器实例化的容器集定义中。复制控制器使用选择器来决定已在运行的 pod 实例数量,以便根据需要进行调整。

复制控制器不会基于负载或流量执行自动扩展,因为复制控制器不会跟踪它们。相反,这需要外部自动缩放器调整其副本数。

复制控制器是名为 ReplicationController 的核心 Kubernetes 对象。

以下是 ReplicationController 定义示例:

3.6.2. 副本集

与 复制控制器 类似,副本集确保在任何给定时间运行指定数量的 pod 副本。副本集与复制控制器之间的区别在于,副本集支持基于集合的选择器要求,而复制控制器只支持基于相等的选择器要求。

只有在您需要自定义更新编配或根本不需要更新时,才使用副本集,否则使用 Deployment。副本集可以独立使用,但由部署使用用来编配 pod 创建、删除和更新。部署会自动管理其副本集,为 pod 提供声明性更新,且不需要手动管理它们创建的副本集。

副本集是一个被称为 ReplicaSet 的核心 Kubernetes 对象。

以下是 ReplicaSet 定义示例:

3.6.3. Jobs

作业类似于复制控制器,其目的在于出于指定的原因创建 pod。不同之处在于复制控制器是为持续运行的容器集设计的,而作业则用于一次性容器集。作业跟踪所有成功完成,并且达到指定数量的完成时,作业本身将完成。

以下示例计算 π 到 2000 个位置,输出它,然后完成:

有关如何使用作业(job)的更多信息,请参阅作业。

3.6.4. 部署和部署配置

在复制控制器的基础上,OpenShift Container Platform 添加了对软件开发和部署生命周期的支持以及部署的概念。在最简单的情形中,部署仅创建一个新复制控制器,并允许它启动 pod。但是,OpenShift Container Platform 部署也提供从镜像的现有部署过渡到新部署的功能,还可定义要在创建复制控制器之前或之后运行的 hook。

OpenShift Container Platform DeploymentConfig 对象定义以下部署详情:

-

ReplicationController定义的元素。 - 自动创建新部署的触发器。

- 在部署之间过渡的策略。

- 生命周期 Hook.

每次触发部署时,无论是手动还是自动,部署器 Pod 均管理部署(包括缩减旧复制控制器、扩展新复制控制器以及运行 hook)。部署 pod 在完成部署后会无限期保留,以便保留其部署日志。当部署被另一个部署替换时,以前的复制控制器会被保留,以便在需要时轻松回滚。

有关如何创建和与部署交互的详细信息,请参阅 Deployment。

以下是含有一些省略和标注的 DeploymentConfig 定义示例:

3.7. 模板

3.7.1. 概述

模板描述了一组可参数化和处理的对象,用于生成对象列表,供 OpenShift Container Platform 用于创建。要创建的对象可以包含用户有权在项目内创建的任何对象,如 服务、构建配置和 部署配置。模板还可定义一系列标签(label),以应用到该模板中定义的每个对象。

有关创建和使用 模板的详细信息,请参阅模板指南。

第 4 章 其他概念

4.1. 身份验证

4.1.1. 概述

身份验证层识别与 OpenShift Container Platform API 请求关联的用户。然后,授权层使用与请求用户相关的信息来确定是否应允许该请求。

作为管理员,您可以使用 主(master)配置文件 配置身份验证。

4.1.2. 用户和组

OpenShift Container Platform 中的用户是可以向 OpenShift Container Platform API 发出请求的实体。通常,这代表与 OpenShift Container Platform 交互的开发人员或管理员的帐户。

用户可以分配到一个或多个组中,每个组代表特定的用户集合。在 管理授权策略 时,可以同时为多个用户授予权限,例如允许访问 项目内 的对象,而不必逐一向用户授予权限。

除了显式定义的组外,还有 OpenShift 自动调配的 系统组或虚拟组。在 查看集群绑定 时可以看到它们。

在默认虚拟组集合中,特别注意以下内容:

| 虚拟组 | 描述 |

|---|---|

| system:authenticated | 自动与所有经过身份验证的用户关联。 |

| system:authenticated:oauth | 自动与所有使用 OAuth 访问令牌经过身份验证的用户关联。 |

| system:unauthenticated | 自动与所有未经身份验证的用户关联。 |

4.1.3. API 身份验证

对 OpenShift Container Platform API 的请求通过以下方式进行身份验证:

- OAuth 访问令牌

-

使用 <master>

/oauth/authorize 和端点从 OpenShift Container Platform OAuth 服务器获取。<master>/oauth/token -

作为

Authorization 发送:Bearer…标头发送。 -

以

base64url.bearer.authorization.k8s.io.<base64url-encoded-token>形式,作为 websocket 请求的 websocket 子协议标头发送。

-

使用 <master>

- X.509 客户端证书

- 需要与 API 服务器的 HTTPS 连接。

- 由 API 服务器针对可信证书颁发机构捆绑包进行验证。

- API 服务器创建证书并分发到控制器,以对自身进行身份验证。

任何具有无效访问令牌或无效证书的请求都会被身份验证层以 401 错误形式拒绝。

如果没有出示访问令牌或证书,身份验证层会将 system:anonymous 虚拟用户和 system:unauthenticated 虚拟组分配给请求。这使得授权层能够决定匿名用户可以发出哪些(如有)请求。

4.1.3.1. 模拟(Impersonation)

对 OpenShift Container Platform API 的请求可以包含 Impersonate-User 标头,这表示请求者希望像来自指定用户一样处理请求。您可以通过在请求中添加 --as=<user> 标志来模拟用户。

在用户 A 可以模拟用户 B 之前,用户 A 通过了身份验证。然后,进行授权检查以确保 User A 可以模仿名为 User B 的用户。如果用户 A 请求模拟服务帐户 system:serviceaccount:namespace:name,OpenShift Container Platform 会确认 User A 可以模仿名为 name 的 serviceaccount 在 命名空间中。如果检查失败,请求会失败,并显示 403(Forbidden)错误代码。

默认情况下,项目管理员和编辑器可以模拟其命名空间中的服务帐户。sudoers 角色允许用户模拟 system:admin,后者具有集群管理员权限。通过模拟 system:admin,可以在用户管理集群时提供一定的拼写错误(而非安全性)的保护。例如,运行 oc delete nodes --all 会失败,但运行 oc delete nodes --all --as=system:admin 会失败。您可以运行以下命令来授予该权限的用户:

oc create clusterrolebinding <any_valid_name> --clusterrole=sudoer --user=<username>

$ oc create clusterrolebinding <any_valid_name> --clusterrole=sudoer --user=<username>

如果您需要代表用户创建项目请求,请在命令中包含 --as=<user> --as-group=<group1> --as-group=<group2> 标志。因为 system:authenticated:oauth 是唯一可以创建项目请求的 bootstrap 组,所以您必须模拟该组,如下例所示:

oc new-project <project> --as=<user> \ --as-group=system:authenticated --as-group=system:authenticated:oauth

$ oc new-project <project> --as=<user> \

--as-group=system:authenticated --as-group=system:authenticated:oauth4.1.4. OAuth

OpenShift Container Platform master 包含内置的 OAuth 服务器。用户获取 OAuth 访问令牌来对自身进行 API 身份验证。

当用户请求新的 OAuth 令牌时,OAuth 服务器使用配置的 身份提供程序 来确定发出请求的人员的身份。

然后,它会确定该身份所映射到的用户,为该用户创建一个访问令牌,再返回要使用的令牌。

4.1.4.1. OAuth 客户端

每个对 OAuth 令牌的请求都必须指定要接收和使用令牌的 OAuth 客户端。启动 OpenShift Container Platform API 时会自动创建以下 OAuth 客户端:

| OAuth 客户端 | 使用方法 |

|---|---|

| openshift-web-console | 为 Web 控制台请求令牌。 |

| openshift-browser-client |

使用可处理交互式登录的用户代理,在 |

| openshift-challenging-client |

使用可处理 |

注册其他客户端:

- 1

- OAuth 客户端

的名称用作提交对 <master>/oauth/authorize 和的请求时的<master>/oauth/tokenclient_id参数。 - 2

- 在提出对

<master>/oauth/token的请求时,secret将作为client_secret参数使用。 - 3

- 在对

<master>/oauth/authorize和<master>/oauth/token的请求中指定的redirect_uri参数必须等于redirectURIs中的某一 URI(或使用它作为前缀)。 - 4

grantMethod用于确定当此客户端请求了令牌且还未被用户授予访问权限时应采取的操作。使用 Grant 选项中看到的相同值。

4.1.4.2. 服务帐户作为 OAuth 客户端

服务帐户可用作受约束形式的 OAuth 客户端。服务帐户只能请求范围的子集,允许访问服务帐户本身的命名空间内的一些基本用户信息和基于角色的功能:

-

user:info -

user:check-access -

role:<any_role>:<serviceaccount_namespace> -

role:<any_role>:<serviceaccount_namespace>:!

在将服务帐户用作 OAuth 客户端时:

-

client_id是system:serviceaccount:<serviceaccount_namespace>:<serviceaccount_name>。 client_secret可以是该服务帐户的任何 API 令牌。例如:oc sa get-token <serviceaccount_name>

$ oc sa get-token <serviceaccount_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

要获取

WWW-Authenticate质询,请将服务帐户上的serviceaccounts.openshift.io/oauth-want-challenges注解设置为 true。 -

redirect_uri必须与服务帐户上的注解匹配。服务帐户的重定向 URI 作为 OAuth 客户端提供了更多信息。

4.1.4.3. 重定向作为 OAuth 客户端的服务帐户的 URI

注解键必须具有前缀 serviceaccounts.openshift.io/oauth-redirecturi. 或 serviceaccounts.openshift.io/oauth-redirectreference.,例如:

serviceaccounts.openshift.io/oauth-redirecturi.<name>

serviceaccounts.openshift.io/oauth-redirecturi.<name>采用最简单形式时,注解可用于直接指定有效的重定向 URI。例如:

"serviceaccounts.openshift.io/oauth-redirecturi.first": "https://example.com" "serviceaccounts.openshift.io/oauth-redirecturi.second": "https://other.com"

"serviceaccounts.openshift.io/oauth-redirecturi.first": "https://example.com"

"serviceaccounts.openshift.io/oauth-redirecturi.second": "https://other.com"

上例中的 first 和 second 后缀用于分隔两个有效的重定向 URI。

在更复杂的配置中,静态重定向 URI 可能还不够。例如,您可能希望路由的所有入口都被视为有效。这时可使用通过 serviceaccounts.openshift.io/oauth-redirectreference. 前缀的动态重定向 URI。

例如:

"serviceaccounts.openshift.io/oauth-redirectreference.first": "{\"kind\":\"OAuthRedirectReference\",\"apiVersion\":\"v1\",\"reference\":{\"kind\":\"Route\",\"name\":\"jenkins\"}}"

"serviceaccounts.openshift.io/oauth-redirectreference.first": "{\"kind\":\"OAuthRedirectReference\",\"apiVersion\":\"v1\",\"reference\":{\"kind\":\"Route\",\"name\":\"jenkins\"}}"由于此注解的值包含序列化 JSON 数据,因此在扩展格式中可以更轻松地查看:

您现在可以看到,OAuthRedirectReference 允许引用名为 jenkins 的路由。因此,该路由的所有入口现在都被视为有效。OAuthRedirectReference 的完整规格是:

可以合并这两个注解前缀,来覆盖引用对象提供的数据。例如:

"serviceaccounts.openshift.io/oauth-redirecturi.first": "custompath"

"serviceaccounts.openshift.io/oauth-redirectreference.first": "{\"kind\":\"OAuthRedirectReference\",\"apiVersion\":\"v1\",\"reference\":{\"kind\":\"Route\",\"name\":\"jenkins\"}}"

"serviceaccounts.openshift.io/oauth-redirecturi.first": "custompath"

"serviceaccounts.openshift.io/oauth-redirectreference.first": "{\"kind\":\"OAuthRedirectReference\",\"apiVersion\":\"v1\",\"reference\":{\"kind\":\"Route\",\"name\":\"jenkins\"}}"

first 后缀用于将注解绑在一起。假设 jenkins 路由的入口为 https://example.com,现在 https://example.com/custompath 被视为有效,但 https://example.com 视为无效。部分提供覆盖数据的格式如下:

| 类型 | 语法 |

|---|---|

| Scheme | "https://" |

| 主机名 | "//website.com" |

| 端口 | "//:8000" |

| 路径 | "examplepath" |

指定主机名覆盖将替换被引用对象的主机名数据,这不一定是需要的行为。

以上语法的任何组合都可以使用以下格式进行合并:

<scheme:>//<hostname><:port>/<path>

同一对象可以被多次引用,以获得更大的灵活性:

"serviceaccounts.openshift.io/oauth-redirecturi.first": "custompath"

"serviceaccounts.openshift.io/oauth-redirectreference.first": "{\"kind\":\"OAuthRedirectReference\",\"apiVersion\":\"v1\",\"reference\":{\"kind\":\"Route\",\"name\":\"jenkins\"}}"

"serviceaccounts.openshift.io/oauth-redirecturi.second": "//:8000"

"serviceaccounts.openshift.io/oauth-redirectreference.second": "{\"kind\":\"OAuthRedirectReference\",\"apiVersion\":\"v1\",\"reference\":{\"kind\":\"Route\",\"name\":\"jenkins\"}}"

"serviceaccounts.openshift.io/oauth-redirecturi.first": "custompath"

"serviceaccounts.openshift.io/oauth-redirectreference.first": "{\"kind\":\"OAuthRedirectReference\",\"apiVersion\":\"v1\",\"reference\":{\"kind\":\"Route\",\"name\":\"jenkins\"}}"

"serviceaccounts.openshift.io/oauth-redirecturi.second": "//:8000"

"serviceaccounts.openshift.io/oauth-redirectreference.second": "{\"kind\":\"OAuthRedirectReference\",\"apiVersion\":\"v1\",\"reference\":{\"kind\":\"Route\",\"name\":\"jenkins\"}}"

假设名为 jenkins 的路由具有入口 https://example.com,则 https://example.com:8000 和 https://example.com/custompath 都被视为有效。

可以同时使用静态和动态注解,以实现所需的行为:

"serviceaccounts.openshift.io/oauth-redirectreference.first": "{\"kind\":\"OAuthRedirectReference\",\"apiVersion\":\"v1\",\"reference\":{\"kind\":\"Route\",\"name\":\"jenkins\"}}"

"serviceaccounts.openshift.io/oauth-redirecturi.second": "https://other.com"

"serviceaccounts.openshift.io/oauth-redirectreference.first": "{\"kind\":\"OAuthRedirectReference\",\"apiVersion\":\"v1\",\"reference\":{\"kind\":\"Route\",\"name\":\"jenkins\"}}"

"serviceaccounts.openshift.io/oauth-redirecturi.second": "https://other.com"4.1.4.3.1. OAuth 的 API 事件

在有些情况下,API 服务器会返回一个 unexpected condition 错误消息;若不直接访问 API 主日志,很难对此消息进行调试。该错误的基本原因被有意遮挡,以避免向未经身份验证的用户提供有关服务器状态的信息。

这些错误的子集与服务帐户 OAuth 配置问题有关。这些问题在非管理员用户可查看的事件中捕获。OAuth 期间遇到 unexpected condition 服务器错误时,可运行 oc get events 在 ServiceAccount 下查看这些事件。

以下示例警告缺少正确 OAuth 重定向 URI 的服务帐户:

oc get events | grep ServiceAccount

$ oc get events | grep ServiceAccount输出示例

1m 1m 1 proxy ServiceAccount Warning NoSAOAuthRedirectURIs service-account-oauth-client-getter system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>

1m 1m 1 proxy ServiceAccount Warning NoSAOAuthRedirectURIs service-account-oauth-client-getter system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>

运行 oc describe sa/<service-account-name> 可以报告与给定服务帐户名称相关的任何 OAuth 事件。

oc describe sa/proxy | grep -A5 Events

$ oc describe sa/proxy | grep -A5 Events输出示例

Events: FirstSeen LastSeen Count From SubObjectPath Type Reason Message --------- -------- ----- ---- ------------- -------- ------ ------- 3m 3m 1 service-account-oauth-client-getter Warning NoSAOAuthRedirectURIs system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>

Events:

FirstSeen LastSeen Count From SubObjectPath Type Reason Message

--------- -------- ----- ---- ------------- -------- ------ -------

3m 3m 1 service-account-oauth-client-getter Warning NoSAOAuthRedirectURIs system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>下方列出可能的事件错误:

无重定向 URI 注解或指定了无效的 URI

Reason Message NoSAOAuthRedirectURIs system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>

Reason Message

NoSAOAuthRedirectURIs system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>指定了无效的路由

Reason Message NoSAOAuthRedirectURIs [routes.route.openshift.io "<name>" not found, system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>]

Reason Message

NoSAOAuthRedirectURIs [routes.route.openshift.io "<name>" not found, system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>]指定了无效的引用类型

Reason Message NoSAOAuthRedirectURIs [no kind "<name>" is registered for version "v1", system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>]

Reason Message

NoSAOAuthRedirectURIs [no kind "<name>" is registered for version "v1", system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>]缺少 SA 令牌

Reason Message NoSAOAuthTokens system:serviceaccount:myproject:proxy has no tokens

Reason Message

NoSAOAuthTokens system:serviceaccount:myproject:proxy has no tokens4.1.4.3.1.1. 因为可能的错误配置导致的示例 API 事件

以下步骤代表用户可以进入出现问题状态的一种方法,以及如何调试或修复问题:

将服务帐户用作 OAuth 客户端,创建项目。

为代理服务帐户对象创建 YAML,并确保它使用路由

代理:vi serviceaccount.yaml

$ vi serviceaccount.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 添加以下示例代码:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 为路由对象创建 YAML,以创建与代理的安全连接:

vi route.yaml

$ vi route.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 添加以下示例代码:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 为部署配置创建 YAML 以作为 sidecar 启动代理:

vi proxysidecar.yaml

$ vi proxysidecar.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 添加以下示例代码:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建三个对象:

oc create -f serviceaccount.yaml

$ oc create -f serviceaccount.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc create -f route.yaml

$ oc create -f route.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc create -f proxysidecar.yaml

$ oc create -f proxysidecar.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

运行

oc edit sa/proxy以编辑服务帐户,并将serviceaccounts.openshift.io/oauth-redirectreference注解更改为指向不存在的路由。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 查看服务的 OAuth 日志以查找服务器错误:

The authorization server encountered an unexpected condition that prevented it from fulfilling the request.

The authorization server encountered an unexpected condition that prevented it from fulfilling the request.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行

oc get events来查看ServiceAccount事件:oc get events | grep ServiceAccount

$ oc get events | grep ServiceAccountCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

23m 23m 1 proxy ServiceAccount Warning NoSAOAuthRedirectURIs service-account-oauth-client-getter [routes.route.openshift.io "notexist" not found, system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>]

23m 23m 1 proxy ServiceAccount Warning NoSAOAuthRedirectURIs service-account-oauth-client-getter [routes.route.openshift.io "notexist" not found, system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>]Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.4.4. 集成

所有对 OAuth 令牌的请求都包括对 <master>/oauth/authorize 的请求。大多数身份验证集成在此端点前放置身份验证代理,或者将 OpenShift Container Platform 配置为针对后备 身份提供程序 验证凭证。对 <master>/oauth/authorize 的请求可能来自不能显示交互式登录页面的用户代理,如 CLI。因此,除了交互式登录流程外,OpenShift Container Platform 也支持使用 WWW-Authenticate 质询进行验证。

如果在 <master>/oauth/authorize 端点前面放置身份验证代理,它会向未经身份验证的非浏览器用户代理发送 WWW-Authenticate 质询,而不是显示交互式登录页面或重定向到交互式登录流程。

为防止浏览器客户端遭受跨站点请求伪造(CSRF)攻击,只有在请求中存在 X-CSRF-Token 标头时,才应发送基本身份验证质询。希望接收基本 WWW-Authenticate 质询的客户端应将此标头设置为非空值。

如果身份验证代理不支持 WWW-Authenticate 质询,或者如果 OpenShift Container Platform 配置为使用不支持 WWW-Authenticate 质询的身份提供程序,用户可以使用浏览器访问 <master> /oauth/token/request 来手动获取访问令牌。

4.1.4.5. OAuth Server Metadata

在 OpenShift Container Platform 中运行的应用可能需要发现有关内置 OAuth 服务器的信息。例如,他们可能需要发现没有手工配置的 <master> 服务器的地址。为此,OpenShift Container Platform 实施了 IETF OAuth 2.0 授权服务器元数据草案规范。

因此,集群中运行的任何应用程序都可以向 https://openshift.default.svc/.well-known/oauth-authorization-server 发出 GET 请求来获取以下信息:

- 1

- 2

- 授权服务器的授权端点的 URL。参见 RFC 6749。

- 3

- 授权服务器的令牌端点的 URL。参见 RFC 6749。

- 4

- 包含此授权服务器支持的 OAuth 2.0 RFC 6749 范围值列表的 JSON 数组。请注意,并非所有支持的范围值都会公告。

- 5

- 包含此授权服务器支持的 OAuth 2.0

response_type值列表的 JSON 数组。使用的数组值与response_types参数(根据 RFC 7591 中“OAuth 2.0 Dynamic Client Registration Protocol”定义)使用的数组值相同。 - 6

- 包含此授权服务器支持的 OAuth 2.0 授权类型值列表的 JSON 数组。使用的数组值与通过

grant_types参数(根据 RFC 7591 中“OAuth 2.0 Dynamic Client Registration Protocol”定义)使用的数组值相同。 - 7

- 包含此授权服务器支持的 PKCE RFC 7636 代码质询方法列表的 JSON 数组。

code_challenge_method参数中使用的代码质询方法值在 RFC 7636 第 4.3 节中定义。有效的代码质询方法值是在 IANA PKCE Code Challenge Methods 注册表中注册的值。请参阅 IANA OAuth 参数。

4.1.4.6. 获取 OAuth 令牌

OAuth 服务器支持标准的授权代码授权和隐式授权 OAuth 授权流。

运行以下命令,使用授权代码授权方法请求 OAuth 令牌:

curl -H "X-Remote-User: <username>" \

--cacert /etc/origin/master/ca.crt \

--cert /etc/origin/master/admin.crt \

--key /etc/origin/master/admin.key \

-I https://<master-address>/oauth/authorize?response_type=token\&client_id=openshift-challenging-client | grep -oP "access_token=\K[^&]*"

$ curl -H "X-Remote-User: <username>" \

--cacert /etc/origin/master/ca.crt \

--cert /etc/origin/master/admin.crt \

--key /etc/origin/master/admin.key \

-I https://<master-address>/oauth/authorize?response_type=token\&client_id=openshift-challenging-client | grep -oP "access_token=\K[^&]*"

在使用隐式授权流 (response_type=token) 以及配置为请求 WWW-Authenticate 质询(如 openshift-challenging-client)的 client_id 以请求 OAuth 令牌时,可能来自 /oauth/authorize 的服务器响应及它们的处理方式如下方所列:

| 状态 | 内容 | 客户端响应 |

|---|---|---|

| 302 |

|

使用 |

| 302 |

|

失败,或向用户显示 |

| 302 |

其他 | 接续重定向操作,并使用这些规则处理结果 |

| 401 |

|

在识别了类型时(如 |

| 401 |

没有 | 无法进行质询身份验证。失败,并显示响应正文(可能包含用于获取 OAuth 令牌的链接或备用方法详情) |

| 其他 | 其他 | 失败,或可向用户显示响应正文 |

使用隐式授权流请求 OAuth 令牌:

curl -u <username>:<password> 'https://<master-address>:8443/oauth/authorize?client_id=openshift-challenging-client&response_type=token' -skv / / -H "X-CSRF-Token: xxx"

$ curl -u <username>:<password>

'https://<master-address>:8443/oauth/authorize?client_id=openshift-challenging-client&response_type=token' -skv /

/ -H "X-CSRF-Token: xxx" 输出示例

要只查看 OAuth 令牌值,请运行以下命令:

curl -u <username>:<password> / 'https://<master-address>:8443/oauth/authorize?client_id=openshift-challenging-client&response_type=token' / -skv -H "X-CSRF-Token: xxx" --stderr - | grep -oP "access_token=\K[^&]*"

$ curl -u <username>:<password> /

'https://<master-address>:8443/oauth/authorize?client_id=openshift-challenging-client&response_type=token' /

-skv -H "X-CSRF-Token: xxx" --stderr - | grep -oP "access_token=\K[^&]*" 输出示例

hvqxe5aMlAzvbqfM2WWw3D6tR0R2jCQGKx0viZBxwmc

hvqxe5aMlAzvbqfM2WWw3D6tR0R2jCQGKx0viZBxwmc

您还可以使用 Code Grant 方法请求令牌。

4.1.4.7. Prometheus 身份验证指标

OpenShift Container Platform 在身份验证尝试过程中捕获以下 Prometheus 系统指标:

-

openshift_auth_basic_password_count统计oc login用户名和密码的尝试次数。 -

openshift_auth_basic_password_count_result按照结果(success 或 error)统计oc login用户名和密码尝试次数。 -

openshift_auth_form_password_count统计 web 控制台登录尝试次数。 -

openshift_auth_form_password_count_result统计 web 控制台登录尝试次数(包括成功和失败的登陆尝试)。 -

openshift_auth_password_total统计oc login和 web 控制台登录尝试总次数。

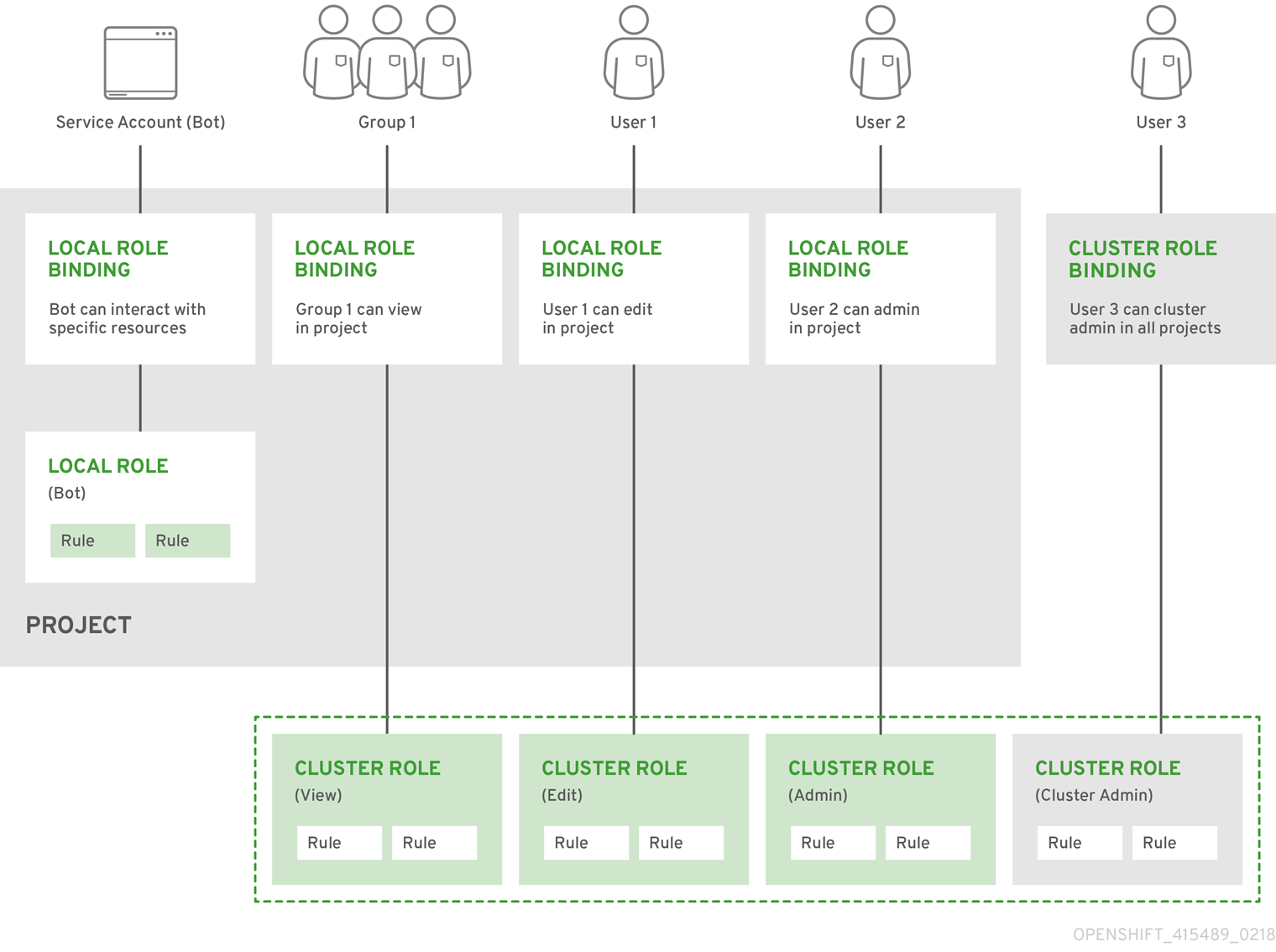

4.2. 授权

4.2.1. 概述

基于角色的访问控制(RBAC)对象确定是否允许用户在项目内执行给定的 操作。

这允许平台管理员使用 集群角色和绑定 来控制谁对 OpenShift Container Platform 平台本身和所有项目具有各种访问权限级别。

开发人员可以 利用本地角色和绑定来控制 谁有权访问 其项目。请注意,授权是独立于 身份验证 的一个步骤,身份验证更在于确定执行操作的人员的身份。

授权通过使用以下几项来管理:

| Rules | |

| Roles | |

| Bindings | 用户和/组与 角色 之间的关联。 |

集群管理员可以使用 CLI 视觉化规则、角色和绑定。

例如,请考虑以下摘录,其中显示了 admin 和 basic-user 默认集群角色 的规则集:

oc describe clusterrole.rbac admin basic-user

$ oc describe clusterrole.rbac admin basic-user输出示例

以下摘录查看本地角色绑定,显示了绑定到不同用户和组的以上角色:

oc describe rolebinding.rbac admin basic-user -n alice-project

$ oc describe rolebinding.rbac admin basic-user -n alice-project输出示例

下方展示了集群角色、本地角色、集群角色绑定、本地角色绑定、用户、组和服务帐户之间的关系。

4.2.2. 评估授权

OpenShift Container Platform 在评估授权时结合了几个因素:

| Identity | 在授权上下文中,用户名和用户所属组的列表。 | ||||||

| 操作 | 正在执行的操作。在大多数情况下,这由以下几项组成:

| ||||||

| 绑定 | 绑定 的完整列表。 |

OpenShift Container Platform 通过以下步骤评估授权:

- 使用身份和项目范围操作来查找应用到用户或所属组的所有绑定。

- 使用绑定来查找应用的所有角色。

- 使用角色来查找应用的所有规则。

- 针对每一规则检查操作,以查找匹配项。

- 如果未找到匹配的规则,则默认拒绝该操作。

4.2.3. 集群和本地 RBAC

控制授权的 RBAC 角色和绑定有两个级别:

| 集群 RBAC | 适用于所有项目 的角色和 绑定。集群范围内存在的角色被视为 集群角色。集群角色绑定只能引用集群角色。 |

| 本地 RBAC | 作用于给定项目 的角色和 绑定。仅存在于项目中的角色被视为 本地角色。本地角色绑定可以引用集群和本地角色。 |

这种双级层次结构允许通过集群角色重新利用多个项目,同时允许通过本地角色在单个项目中自定义。

在评估过程中,同时使用集群角色绑定和本地角色绑定。例如:

- 选中集群范围的“allow”规则。

- 选中本地绑定的“allow”规则。

- 默认为拒绝。

4.2.4. 集群角色和本地角色

角色是策略 规则 的集合,这是一组可以对一组资源执行的允许动词。OpenShift Container Platform 包含一组默认的集群角色,可以绑定到集群范围 或 本地的 用户和组。

| 默认集群角色 | 描述 |

|---|---|

| admin | 项目管理者。如果 在本地绑定 中使用,admin 用户将有权查看项目中的任何资源,并且修改项目中除配额外的任何资源。 |

| basic-user | 此用户可以获取有关项目和用户的基本信息。 |

| cluster-admin | |

| cluster-status | 此用户可以获取基本的集群状态信息。 |

| edit | 此用户可以修改项目中的大多数对象,但没有权限查看或修改角色或绑定。 |

| self-provisioner | 此用户可以创建自己的项目。 |

| view | 此用户无法进行任何修改,但可以查看项目中的大多数对象。不能查看或修改角色或绑定。 |

| cluster-reader | 此用户可以读取(但不能查看)集群中的对象。 |

请记住,用户和组可以同时关联或绑定到多个角色。

项目管理员可以视觉化角色,包括使用 CLI 关联的操作动词和资源列表 来查看本地角色和绑定。

通过 本地绑定 绑定到项目管理员的集群角色在项目中受到限制。它不会像授权给 cluster-admin 或 system : admin 的 集群角色那样在集群范围 绑定。

集群角色是在集群级别上定义的角色,但可以在集群级别或项目级别绑定。

4.2.4.1. 更新集群角色

任何 OpenShift Container Platform 集群升级后,会在服务器启动时更新默认角色并自动协调。在协调过程中,会添加默认角色中缺少的任何权限。如果您向角色添加了更多权限,则不会删除它们。

如果您自定义默认角色并配置了这些角色以防止自动角色协调,则必须在升级 OpenShift Container Platform 时 手动更新策略定义。

4.2.4.2. 应用自定义角色和权限

要更新自定义角色和权限,强烈建议您使用以下命令:

oc auth reconcile -f <file>

$ oc auth reconcile -f <file> 您还可以使用此命令来添加新的自定义角色和权限。如果新自定义角色的名称与现有角色的名称相同,则会更新现有的角色。集群管理员不会收到名称相同的自定义角色通知。

此命令可确保以不会破坏其他客户端的方式正确应用新权限。这通过计算逻辑在规则集之间的操作在内部完成,这是您无法通过 RBAC 资源上的 JSON 合并执行的操作。

4.2.4.3. 集群角色聚合

默认的 admin、edit、view 和 cluster-reader 集群角色支持集群角色聚合,其中每个角色的集群规则会在创建新规则时动态更新。只有在您通过创建自定义资源 扩展 Kubernetes API 时,此功能才有意义。

4.2.5. 安全性上下文约束

除了控制用户可执行的操作的 RBAC 资源 外,OpenShift Container Platform 还提供 安全性上下文约束 (SCC)来控制 Pod 可以执行的操作以及它有权访问的内容。管理员可以使用 CLI 管理 SCC。

SCC 在管理对持久存储的访问时也非常有用。

SCC 是定义 Pod 运行必须满足的一组条件的对象,以便其能被系统接受。它们允许管理员控制以下内容:

- 运行特权容器。

- 容器可请求添加的功能

- 将主机目录用作卷。

- 容器的 SELinux 上下文。

- 用户 ID。

- 使用主机命名空间和联网。

-

分配拥有 pod 卷的

FSGroup - 配置允许的补充组

- 要求使用只读根文件系统

- 控制卷类型的使用

- 配置允许的 seccomp 配置集

默认情况下,在集群中添加七个 SCC,集群管理员可使用 CLI 查看它们:

oc get scc

$ oc get scc输出示例

不要修改默认 SCC。修改默认 SCC 可导致升级 OpenShift Container Platform 时出现问题。而是 创建新的 SCC。

集群管理员也可以使用 CLI 查看各个 SCC 的定义。例如,对于特权 SCC:

oc get -o yaml --export scc/privileged

$ oc get -o yaml --export scc/privileged输出示例

SCC 上的 users 和 groups 字段控制可以使用哪些 SCC。默认情况下,集群管理员、节点和构建控制器被授予特权 SCC 的访问权限。所有经过身份验证的用户被授予受限 SCC 的访问权限。

Docker 具有允许用于 Pod 的每个容器的默认功能列表。容器使用此默认列表中的功能,但 Pod 清单作者可以通过请求额外的功能或丢弃一些默认功能来修改它。allowedCapabilities、defaultAddCapabilities 和 requiredDropCapabilities 字段用于控制来自 Pod 的此类请求,并指定可以请求哪些功能、必须为每个容器添加哪些功能,以及必须禁止哪些功能。

特权 SCC:

- 允许特权 pod。

- 允许将主机目录挂载为卷.

- 允许容器集以任何用户身份运行。

- 允许 Pod 使用任何 MCS 标签运行。

- 允许 pod 使用主机的 IPC 命名空间。

- 允许容器集使用主机的 PID 命名空间。

- 允许容器集使用任何 FSGroup。

- 允许容器集使用任何补充组。

- 允许容器集使用任何 seccomp 配置集。

- 允许容器集请求任何功能。

受限 SCC:

- 确保 Pod 无法以特权方式运行。

- 确保容器集无法使用主机目录卷。

- 要求容器集以预先分配的 UID 范围内的用户运行。

- 要求 Pod 使用预先分配的 MCS 标签运行。

- 允许容器集使用任何 FSGroup。

- 允许容器集使用任何补充组。

如需有关各个 SCC 的更多信息,请参阅 SCC 的 kubernetes.io/description 注解。

SCC 由设置和策略组成,它们控制容器集可以访问的安全功能。这些设置分为三个类别:

| 由布尔值控制 |

此类型的字段默认为限制性最强的值。例如, |

| 由允许的集合控制 | 针对集合检查此类型的字段,以确保其值被允许。 |

| 由策略控制 | 具有生成某个值的策略的条目提供以下功能:

|

4.2.5.1. SCC 策略

4.2.5.1.1. RunAsUser

-

MustRunAs - 需要配置

runAsUser。使用配置的runAsUser作为默认值。针对配置的runAsUser进行验证。 - MustRunAsRange - 如果不使用预分配值,则需要定义最小值和最大值。使用最小值作为默认值。针对整个允许范围进行验证。

-

MustRunAsNonRoot - 需要 Pod 提交为具有非零

runAsUser或具有镜像中定义的USER指令。不提供默认值。 -

RunAsAny - 不提供默认值。允许指定任何

runAsUser。

4.2.5.1.2. SELinuxContext

-

MustRunAs - 如果不使用预分配的值,则需要配置

seLinuxOptions。使用seLinuxOptions作为默认值。针对使用seLinuxOptions进行验证。 -

RunAsAny - 不提供默认值。允许指定任何

seLinuxOptions。

4.2.5.1.3. SupplementalGroups

- MustRunAs - 如果不使用预分配值,则需要至少指定一个范围。使用第一个范围内的最小值作为默认值。针对所有范围进行验证。

-

RunAsAny - 不提供默认值。允许指定任何

supplementalGroups。

4.2.5.1.4. FSGroup

- MustRunAs - 如果不使用预分配值,则需要至少指定一个范围。使用第一个范围内的最小值作为默认值。针对第一个范围内的第一个 ID 进行验证。

-

RunAsAny - 不提供默认值。允许指定任何

fsGroupID。

4.2.5.2. 控制卷

通过设置 SCC 的 volumes 字段,控制特定卷类型的使用。此字段的允许值与创建卷时定义的卷来源对应:

- azureFile

- azureDisk

- flocker

- flexVolume

- hostPath

- emptyDir

- gcePersistentDisk

- awsElasticBlockStore

- secret

- nfs

- iscsi

- glusterfs

- persistentVolumeClaim

- rbd

- cinder

- cephFS

- downwardAPI

- fc

- configMap

- vsphereVolume

- quobyte

- photonPersistentDisk

- projected

- portworxVolume

- scaleIO

- storageos

- *(允许使用所有卷类型的一个特殊值)

- none(禁止使用所有卷类型的一个特殊值。仅为向后兼容而存在)

为新 SCC 推荐的允许卷最小集合是 configMap、downAPI、emptyDir、persistentVolumeClaim、secret 和 projected。

允许卷类型列表并不完整,因为每次发布新版 OpenShift Container Platform 时都会添加新的类型。

为向后兼容,使用 allowHostDirVolumePlugin 将覆盖 volumes 字段中的设置。例如,如果 allowHostDirVolumePlugin 设为 false,但在 volumes 字段中是允许,则将移除 volumes 中的 hostPath 值。

4.2.5.3. 限制对 FlexVolumes 的访问

OpenShift Container Platform 基于其驱动程序提供 FlexVolumes 的额外控制。当 SCC 允许 FlexVolumes 时,pod 可以请求任何 FlexVolumes。但是,当集群管理员在 AllowedFlexVolumes 字段中指定驱动程序名称时,pod 只能使用这些驱动程序的 FlexVolume。

只允许两个 FlexVolume 的限制示例

volumes: - flexVolume allowedFlexVolumes: - driver: example/lvm - driver: example/cifs

volumes:

- flexVolume

allowedFlexVolumes:

- driver: example/lvm

- driver: example/cifs4.2.5.4. seccomp

SeccompProfiles 列出了可为 pod 或容器的 seccomp 注解设置的允许的配置集。unset(nil)或空值表示 pod 或容器没有指定配置集。使用通配符 * 允许所有配置集。当用于生成 pod 的值时,第一个非通配符配置集被用作默认值。

有关配置和使用自定义配置集的更多信息,请参阅 seccomp 文档。

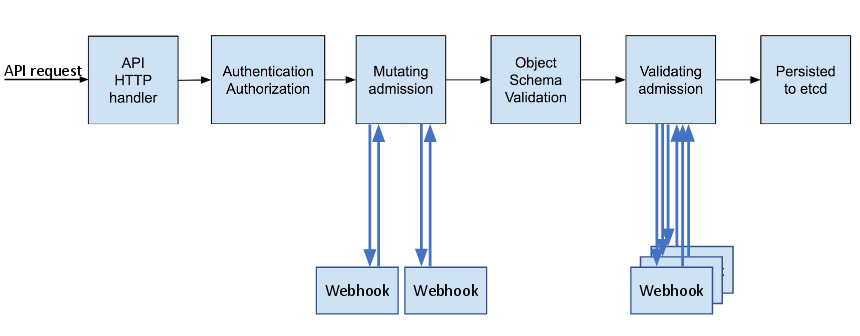

4.2.5.5. 准入

利用 SCC 的准入控制可以根据授予用户的能力来控制资源的创建。

就 SCC 而言,这意味着准入控制器可以检查上下文中提供的用户信息以检索一组合适的 SCC。这样做可确保 Pod 具有相应的授权,能够提出与其操作环境相关的请求或生成一组要应用到 Pod 的约束。

准入用于授权 Pod 的 SCC 集合由用户身份和用户所属的组来决定。另外,如果 Pod 指定了服务帐户,则允许的 SCC 集合包括服务帐户可访问的所有约束。

准入使用以下方法来创建 Pod 的最终安全性上下文:

- 检索所有可用的 SCC。

- 为请求上未指定的安全性上下文设置生成字段值。

- 针对可用约束来验证最终设置。

如果找到了匹配的约束集合,则接受 Pod。如果请求不能与 SCC 匹配,则拒绝 Pod。

Pod 必须针对 SCC 验证每一个字段。以下示例中只有其中两个字段必须验证:

这些示例是在使用预分配值的策略的上下文中。

FSGroup SCC 策略为 MustRunAs

如果 Pod 定义了 fsGroup ID,该 ID 必须等于默认的 fsGroup ID。否则,Pod 不会由该 SCC 验证,而会评估下一个 SCC。

如果 SecurityContextConstraints.fsGroup 字段的值为 RunAsAny,并且 Pod 规格省略了 Pod.spec.securityContext.fsGroup,则此字段被视为有效。注意在验证过程中,其他 SCC 设置可能会拒绝其他 Pod 字段,从而导致 Pod 失败。

SupplementalGroups SCC 策略为 MustRunAs

如果 Pod 规格定义了一个或多个 supplementalGroups ID,则 Pod 的 ID 必须等于命名空间的 openshift.io/sa.scc.supplemental-groups 注解中的某一个 ID。否则,Pod 不会由该 SCC 验证,而会评估下一个 SCC。

如果 SecurityContextConstraints.supplementalGroups 字段的值为 RunAsAny,并且 Pod 规格省略了 Pod.spec.securityContext.supplementalGroups,则此字段被视为有效。注意在验证过程中,其他 SCC 设置可能会拒绝其他 Pod 字段,从而导致 Pod 失败。

4.2.5.5.1. SCC 优先级

SCC 有一个优先级字段,它会影响准入控制器尝试验证请求时的排序。在排序时,高优先级 SCC 移到集合的前面。确定了可用 SCC 的完整集合后,按照以下方式排序:

- 优先级最高的在前,nil 视为 0 优先级

- 如果优先级相等,则 SCC 按照限制性最强到最弱排序

- 如果优先级和限制性都相等,则 SCC 按照名称排序

默认情况下,授予集群管理员的 anyuid SCC 在 SCC 集合中具有优先权。这使得集群管理员能够以任意用户运行 Pod,而不必在 Pod 的 SecurityContext 中指定 RunAsUser。若有需要,管理员仍然可以指定 RunAsUser。

4.2.5.5.2. 对 SCC 的基于角色的访问控制

从 OpenShift Container Platform 3.11 开始,您可以将 SCC 指定为由 RBAC 处理的资源。这样,您可以将对 SCC 访问的范围限定为某一项目或整个集群。直接将用户、组或服务帐户分配给 SCC 可保留集群范围的范围。

要为角色包含对 SCC 的访问,您可以在 role 的定义中指定以下规则: .Role-Based Access to SCC

具有这样的规则的本地或集群角色允许以 rolebinding 或 clusterrolebinding 与其绑定的主体使用用户定义的 SCC,名为 myPermittingSCC。

由于 RBAC 旨在防止升级,因此即使项目管理员也无法授予 SCC 访问权限,因为它们默认不被允许,使用 动词对 SCC 资源(包括 restricted SCC)。

4.2.5.5.3. 了解预分配值和安全性上下文约束

准入控制器清楚安全性上下文约束中的某些条件,这些条件会触发它从命名空间中查找预分配值并在处理 pod 前填充安全性上下文约束。每个 SCC 策略都独立于其他策略进行评估,每个策略的预分配值(允许)与 Pod 规格值聚合,为运行的 Pod 中定义的不同 ID 生成最终值。

以下 SCC 导致准入控制器在 Pod 规格中没有定义范围时查找预分配值:

-

RunAsUser策略为 MustRunAsRange 且未设置最小或最大值。准入查找 openshift.io/sa.scc.uid-range 注解来填充范围字段。 -

SELinuxContext策略为 MustRunAs 且未设定级别。准入查找 openshift.io/sa.scc.mcs 注解来填充级别。 -

FSGroup策略为 MustRunAs。准入查找 openshift.io/sa.scc.supplemental-groups 注解。 -

SupplementalGroups策略为 MustRunAs。准入查找 openshift.io/sa.scc.supplemental-groups 注解。

在生成阶段,安全性上下文提供程序将默认使用 pod 中未具体设置的任何值。默认基于所使用的策略:

-

RunAsAny和MustRunAsNonRoot策略不提供默认值。因此,如果 pod 需要定义有一个字段(如组 ID),必须在 pod 规格中定义此字段。 -

MustRunAs(单值)策略提供始终使用的默认值。例如,对于组 ID:即使 pod 规格定义了自己的 ID 值,命名空间的默认字段也会出现在 pod 的组中。 -

MustRunAsRange和MustRunAs(基于范围)策略提供范围的最小值。与单值MustRunAs策略一样,命名空间的默认值将出现在运行的 Pod 中。如果基于范围的策略可以配置多个范围,它会提供第一个配置范围内的最小值。

如果命名空间上不存在 openshift.io/sa.scc.supplemental-groups 注解,则 FSGroup 和 SupplementalGroups 策略回退到 openshift.io/sa.scc.uid-range 注解。如果两者都不存在,则 SCC 将无法创建。

默认情况下,基于注解的 FSGroup 策略使用基于注解的最小值的单个范围来配置其自身。例如,如果您的注解显示为 1/3,则 FSGroup 策略会将其自身配置为最小和最大 1。如果要允许 FSGroup 字段接受多个组,可以配置不使用注解的自定义 SCC。

openshift.io/sa.scc.supplemental-groups 注解接受以逗号分隔的块列表,格式为 < start>/<length 或 < start>-<end>。openshift.io/sa.scc.uid-range 注解只接受一个块。

4.2.6. 确定您可以作为经过身份验证的用户执行什么操作

在 OpenShift Container Platform 项目中,您可以确定您可以对所有命名空间范围的资源(包括第三方资源)执行的操作动词。运行:

oc policy can-i --list --loglevel=8

$ oc policy can-i --list --loglevel=8输出将帮助您确定收集信息的 API 请求。

要以用户可读格式接收信息,请运行:

oc policy can-i --list

$ oc policy can-i --list输出中会提供一个完整的列表。

要确定您可以执行特定的动词 , 请运行:

oc policy can-i <verb> <resource>

$ oc policy can-i <verb> <resource>用户范围 可以提供有关给定范围的更多信息。例如:

oc policy can-i <verb> <resource> --scopes=user:info

$ oc policy can-i <verb> <resource> --scopes=user:info4.3. 持久性存储

4.3.1. 概述

管理存储与管理计算资源不同。OpenShift Container Platform 使用 Kubernetes 持久性卷 (PV) 框架来允许集群管理员为集群提供持久性存储。开发者可以使用持久性卷声明 (PVC) 来请求 PV 资源而无需具体了解底层存储基础架构。

PVC 特定于 某个项目,开发人员会创建和使用 PV。PV 资源本身并不特定于某一个项目; 它们可以在整个 OpenShift Container Platform 集群间共享,并可以被任何项目使用。当 PV 绑定到 PVC 后,但该 PV 不能绑定到额外的 PVC。这会使绑定的 PV 限定为 一个命名空间 (绑定项目是什么)。

PV 由一个 persistentVolume API 对象定义,它代表了集群管理员置备的已存在的网络存储。它与一个节点一样,是一个集群资源。PV 是卷插件,与 Volumes 资源类似,但PV 的生命周期独立于任何使用它的 pod。PV 对象获取具体存储(NFS、iSCSI 或者特定 cloud-provider 的存储系统)的实现详情。

存储的高可用性功能由底层的存储架构提供。

PVC 由 PersistentVolumeClaim API 项定义,它代表了开发人员对存储的一个请求。它与一个 pod 类似,pod 会消耗节点资源, PVC 消耗 PV 资源。例如,pod 可以请求特定级别的资源(如 CPU 和内存),而 PVC 可以请求特定 的存储容量 和访问模式 (例如,可以在读/写或多次只读时挂载它们)。

4.3.2. 卷和声明的生命周期

PV 是集群中的资源。PVC 是对这些资源的请求,也是对该资源的声明检查。PV 和 PVC 之间的交互有以下生命周期。

4.3.2.1. 置备存储

根据 PVC 中定义的开发人员的请求,集群管理员配置一个或者多个动态置备程序用来置备存储及一个匹配的 PV。

另外,集群管理员也可以预先创建多个 PV,它们包含了可用存储的详情。PV 存在于 API 中,且可以被使用。

4.3.2.2. 绑定声明

当您创建 PVC 时,您会要求特定的存储量,指定所需的访问模式,并创建一个存储类来描述和分类存储。master 中的控制循环会随时检查是否有新的 PVC,并把新的 PVC 与一个适当的 PV 进行绑定。如果没有适当的 PV,则存储类的置备程序会生成一个适当的 PV。

PV 卷可能会超过您请求的卷。这在手动置备 PV 时尤为如此。要最小化超额,OpenShift Container Platform 将会把 PVC 绑定到匹配所有其他标准的最小 PV。

如果匹配的卷不存在,或者无法使用任何可用的置备程序提供存储类来创建,则声明将无限期保留。当出现了匹配的卷时,相应的声明就会与其绑定。例如:在一个集群中有多个手动置备的 50Gi 卷。它们无法和一个请求 100Gi 的 PVC 相匹配。当在这个集群中添加了一个 100Gi PV 时, PVC 就可以和这个 PV 绑定。

4.3.2.3. 使用 pod 和声明的 PV

pod 使用声明(claim)作为卷。集群通过检查声明来找到绑定的卷,并为 pod 挂载相应的卷。对于那些支持多个访问模式的卷,您必须指定作为 pod 中的卷需要使用哪种模式。

在声明且该声明被绑定后,绑定的 PV 就会属于您,只要您需要它。您可以通过在 pod 的 volumes 定义中包括 persistentVolumeClaim 来调度 pod 并访问声明的 PV。请参见以下 语法详情。

4.3.2.4. PVC 保护

PVC 保护会被默认启用。

4.3.2.5. 释放卷

当不再需要使用一个卷时,您可以从 API 中删除 PVC 对象,这样相应的资源就可以被重新声明。当声明被删除时,该卷被视为"released",但它尚不可用于其他声明。这是因为之前声明者的数据仍然还保留在卷中,这些数据必须根据相关政策进行处理。

4.3.2.6. 重新声明卷

PersistentVolume 的重新声明(reclaim)政策指定了在卷被释放后集群可以如何使用它。PV 的重新声明策略可以是 Retain 或 Delete。

-

Retain策略可为那些支持它的卷插件手动重新声明资源。 -

删除重新声明(reclaim)策略从 OpenShift Container Platform 以及外部基础架构(如 AWS EBS、GCE PD 或 Cinder 卷)中的相关存储资产中删除PersistentVolume对象。

动态置备的卷具有默认的 ReclaimPolicy 值 Delete。手动置备的卷具有默认的 ReclaimPolicy 值 Retain。

4.3.2.7. 手动重新声明 PersistentVolume

删除 PersistentVolumeClaim 时,PersistentVolume 仍然存在,并被视为 "released"。但是,由于之前声明的数据保留在卷中,所以无法再使用 PV。

要以集群管理员的身份手动重新声明 PV:

删除 PV:

oc delete <pv-name>

$ oc delete <pv-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 外部基础架构(如 AWS EBS、GCE PD、Azure Disk 或 Cinder 卷)中的关联的存储资产在 PV 被删除后仍然存在。

- 清理相关存储资产中的数据。

- 删除关联的存储资产。另外,若要重复使用同一存储资产,请使用存储资产定义创建新 PV。

重新声明的 PV 现在可供另一个 PVC 使用。

4.3.2.8. 更改重新声明策略

更改 PV 的重新声明策略:

列出集群中的 PV:

oc get pv

$ oc get pvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME CAPACITY ACCESSMODES RECLAIMPOLICY STATUS CLAIM STORAGECLASS REASON AGE pvc-b6efd8da-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim1 manual 10s pvc-b95650f8-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim2 manual 6s pvc-bb3ca71d-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim3 manual 3s

NAME CAPACITY ACCESSMODES RECLAIMPOLICY STATUS CLAIM STORAGECLASS REASON AGE pvc-b6efd8da-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim1 manual 10s pvc-b95650f8-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim2 manual 6s pvc-bb3ca71d-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim3 manual 3sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 选择一个 PV 并更改其重新声明策略:

oc patch pv <your-pv-name> -p '{"spec":{"persistentVolumeReclaimPolicy":"Retain"}}'$ oc patch pv <your-pv-name> -p '{"spec":{"persistentVolumeReclaimPolicy":"Retain"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 验证您选择的 PV 是否有正确的策略:

oc get pv