This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.Operator

在 OpenShift Container Platform 中使用 Operator

摘要

第 1 章 了解 Operator

从概念上讲,Operator 会收集人类操作知识,并将其编码成更容易分享给消费者的软件。

Operator 是一组软件,可用于降低运行其他软件的操作复杂程度。它可以被看作是软件厂商的工程团队的扩展,可以在 Kubernetes 环境中(如 OpenShift Container Platform)监控软件的运行情况,并根据软件的当前状态实时做出决策。Advanced Operator 被设计为用来无缝地处理升级过程,并对出现的错误自动进行响应,而且不会采取“捷径”(如跳过软件备份过程来节省时间)。

从技术上讲,Operator 是一种打包、部署和管理 Kubernetes 应用程序的方法。

Kubernetes 应用程序是一款 app,可在 Kubernetes 上部署,也可使用 Kubernetes API 和 kubectl 或 oc 工具进行管理。要想充分利用 Kubernetes,您需要一组统一的 API 进行扩展,以便服务和管理 Kubernetes 上运行的应用程序。可将 Operator 看成管理 Kubernetes 中这类应用程序的运行时。

1.1. 为什么要使用 Operator?

Operator 可以:

- 重复安装和升级。

- 持续对每个系统组件执行运行状况检查。

- 无线 (OTA) 更新 OpenShift 组件和 ISV 内容。

- 汇总现场工程师了解的情况并将其传输给所有用户,而非一两个用户。

- 为什么在 Kubernetes 上部署?

- Kubernetes(扩展至 OpenShift Container Platform)包含构建复杂分布式系统(可在本地和云提供商之间工作)需要的所有原语,包括 secret 处理、负载均衡、服务发现、自动扩展。

- 为什么使用 Kubernetes API 和

kubectl工具来管理您的应用程序? -

这些 API 功能丰富,所有平台均有对应的客户端,并可插入到集群的访问控制/审核中。Operator 会使用 Kubernetes 的扩展机制“自定义资源定义 (CRD)”支持您的自定义对象,如

MongoDB,它类似于内置的原生 Kubernetes 对象。 - Operator 与 Service Broker 相比怎么样?

- Service Broker 朝着实现应用程序的编程式发现和部署的目标前进了一步。但它并非一个长时间运行的进程,所以无法执行第 2 天操作,如升级、故障转移或扩展。它在安装时提供对可调参数的自定义和参数化,而 Operator 则可持续监控集群的当前状态。非集群服务仍非常适合于 Service Broker,但也存在合适于这些服务的 Operator。

1.2. Operator Framework

Operator Framework 是基于上述客户体验提供的一系列工具和功能。不仅仅是编写代码;测试、交付和更新 Operator 也同样重要。Operator Framework 组件包含用于解决这些问题的开源工具:

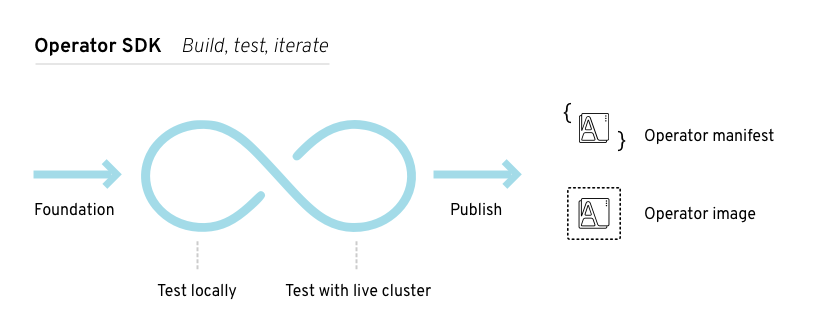

- Operator SDK

- Operator SDK 辅助 Operator 作者根据自身专业知识,引导、构建、测试和包装其 Operator,而无需了解 Kubernetes API 的复杂性。

- Operator Lifecycle Manager

- Operator Lifecycle Manager (OLM) 控制集群中 Operator 的安装、升级和基于角色的访问控制 (RBAC)。在 OpenShift Container Platform 4.3 中默认部署。

- Operator Registry

- Operator Registry 存储 ClusterServiceVersions (CSV) 和自定义资源定义 (CRD) 以便在集群中创建,并存储有关软件包和频道的 Operator 元数据。它运行在 Kubernetes 或 OpenShift 集群中,向 OLM 提供这些 Operator 目录数据。

- OperatorHub

- OperatorHub 是一个 Web 控制台,供集群管理员用来发现并选择要在其集群上安装的 Operator。它在 OpenShift Container Platform 中默认部署。

- Operator Metering

- Operator Metering 收集集群上有关 Operator 的操作指标(用于第 2 天的管理)和聚集使用指标。

这些工具可组合使用,因此您可自由选择对您有用的工具。

1.3. Operator 成熟度模型

Operator 内部封装的管理逻辑的复杂程度各有不同。该逻辑通常还高度依赖于 Operator 所代表的服务类型。

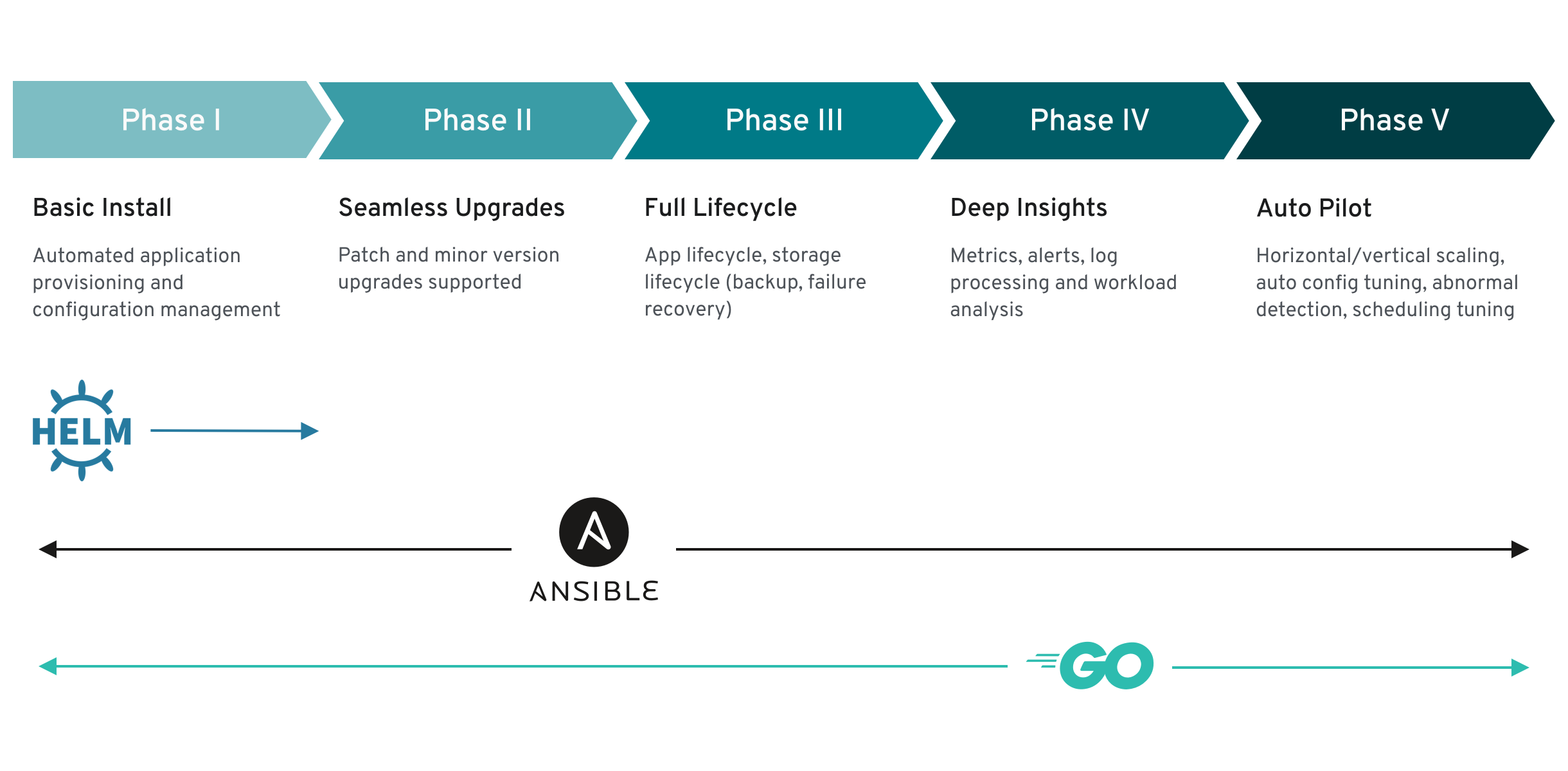

但对于大部分 Operator 可能包含的特定功能集来说,可以大致推断出 Operator 封装操作的成熟度等级。就此而言,以下 Operator 成熟度模型针对 Operator 的第 2 天通用操作定义了五个成熟度阶段。

图 1.1. Operator 成熟度模型

以上模型还展示了如何通过 Operator SDK 的 Helm、Go 和 Ansible 功能来更好地开发这些功能。

第 2 章 了解 Operator Lifecycle Manager (OLM)

2.1. Operator Lifecycle Manager 工作流和架构

该指南概述了 OpenShift Container Platform 中 Operator Lifecycle Manager (OLM) 的概念和架构。

2.1.1. Operator Lifecycle Manager 概述

在 OpenShift Container Platform 4.3 中,Operator Lifecycle Manager (OLM) 可帮助用户安装、更新和管理所有 Operator 以及在用户集群中运行的关联服务的生命周期。Operator Lifecycle Manager 是 Operator Framework 的一部分,后者是一个开源工具包,用于以有效、自动化且可扩展的方式管理 Kubernetes 原生应用程序 (Operator)。

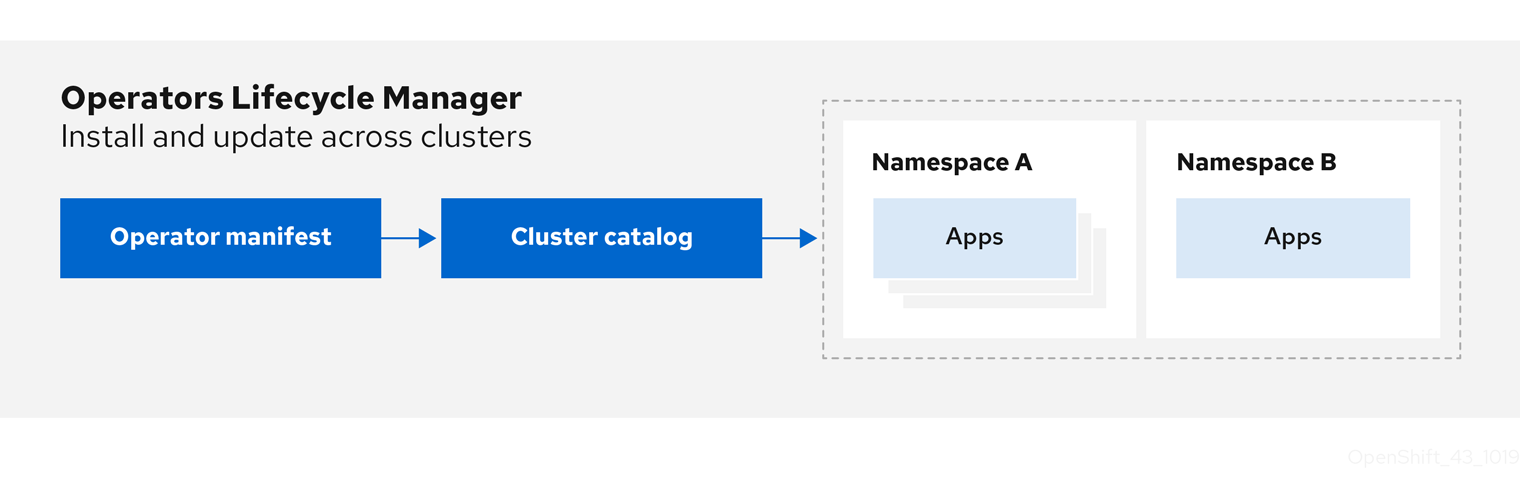

图 2.1. Operator Lifecycle Manager 工作流

OLM 默认在 OpenShift Container Platform 4.3 中运行,辅助集群管理员对集群上运行的 Operator 进行安装、升级和授予访问权。OpenShift Container Platform Web 控制台提供一些管理界面,供集群管理员安装 Operator,以及为特定项目授权以便使用集群上的可用 Operator 目录。

开发人员通过自助服务体验,无需成为相关问题的专家也可自由置备和配置数据库、监控和大数据服务的实例,因为 Operator 已将相关知识融入其中。

2.1.2. ClusterServiceVersions (CSV)

ClusterServiceVersion (CSV) 是一个利用 Operator 元数据创建的 YAML 清单,可辅助 Operator Lifecycle Manager (OLM) 在集群中运行 Operator。

CSV 是 Operator 容器镜像附带的元数据,用于在用户界面填充徽标、描述和版本等信息。此外,CSV 还是运行 Operator 所需的技术信息来源,类似于其需要的 RBAC 规则及其管理或依赖的自定义资源 (CR)。

CSV 包含以下内容:

- 元数据

应用程序元数据:

- 名称、描述、版本(符合 semver)、链接、标签、图标等。

- 安装策略

类型:部署

- 服务账户和所需权限集

- 部署集。

- CRD

- 类型

- 自有:由该服务管理

- 必需:集群中必须存在,该服务才可运行

- 资源:Operator 与之交互的资源列表

- 描述符:注解 CRD 规格和状态字段以提供语义信息

2.1.3. OLM 中的 Operator 安装和升级工作流

在 Operator Lifecycle Manager (OLM) 生态系统中,以下资源用于解决 Operator 的安装和升级问题:

- ClusterServiceVersion (CSV)

- CatalogSource

- Subscription

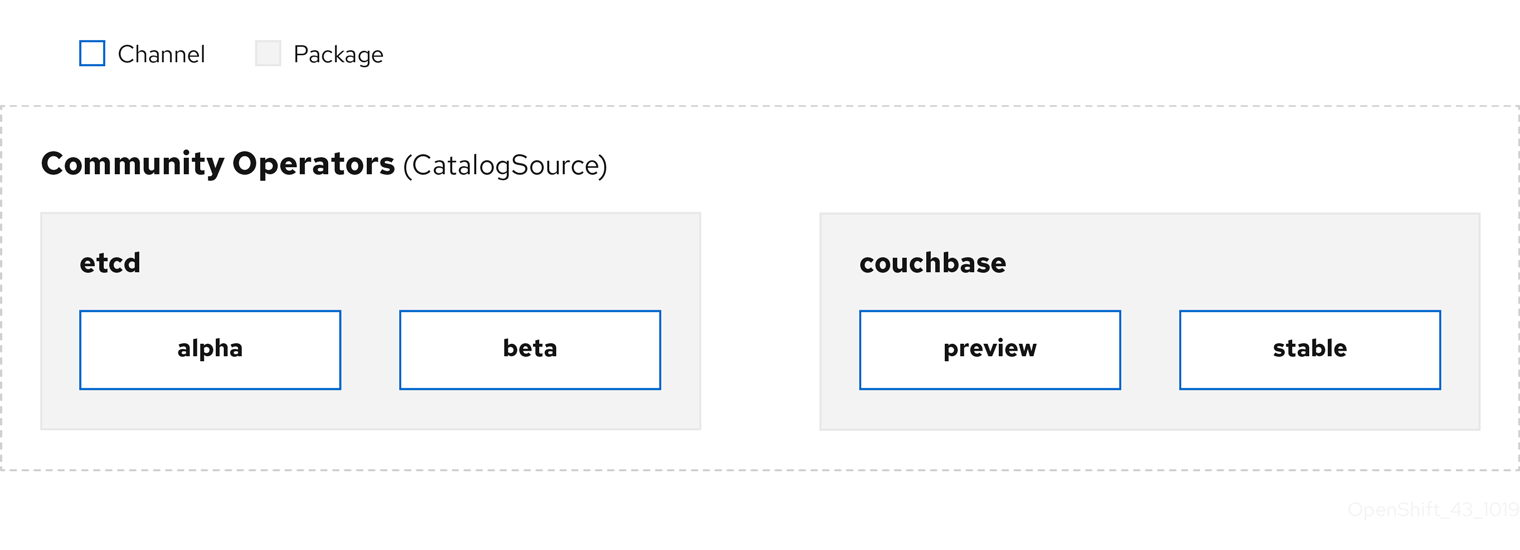

CSV 中定义的 Operator 元数据可保存在一个名为 CatalogSource 的集合中。CatalogSource 使用 Operator Registry API,OLM 又使用 CatalogSource 来查询是否有可用的 Operator 及已安装 Operator 是否有升级版本。

图 2.2. CatalogSource 概述

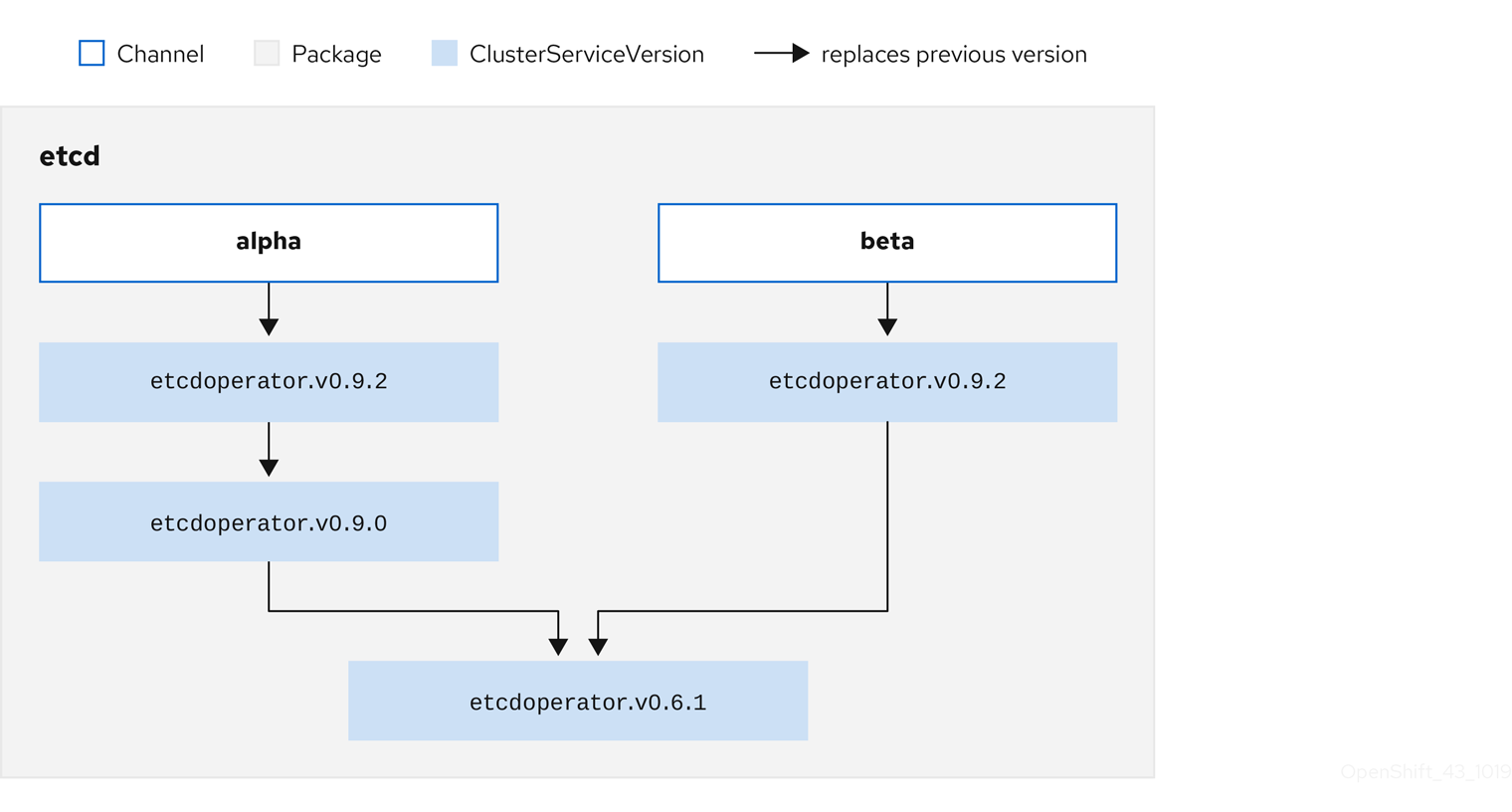

在 CatalogSource 中,Operator 被整合为更新软件包和更新流,我们称为频道,这应是 OpenShift Container Platform 或其他软件(如 Web 浏览器)在持续发行周期中的常见更新模式。

图 2.3. CatalogSource 中的软件包和频道

用户在 Subscription 中的特定 CatalogSource 中指示特定软件包和频道,如 etcd 包及其 alpha 频道。如果订阅了命名空间中尚未安装的软件包,则会安装该软件包的最新 Operator。

OLM 会刻意避免版本比较,因此给定 catalog → channel → package 路径提供的“latest”或“newest”Operator 不一定是最高版本号。更应将其视为频道的 head 引用,类似 Git 存储库。

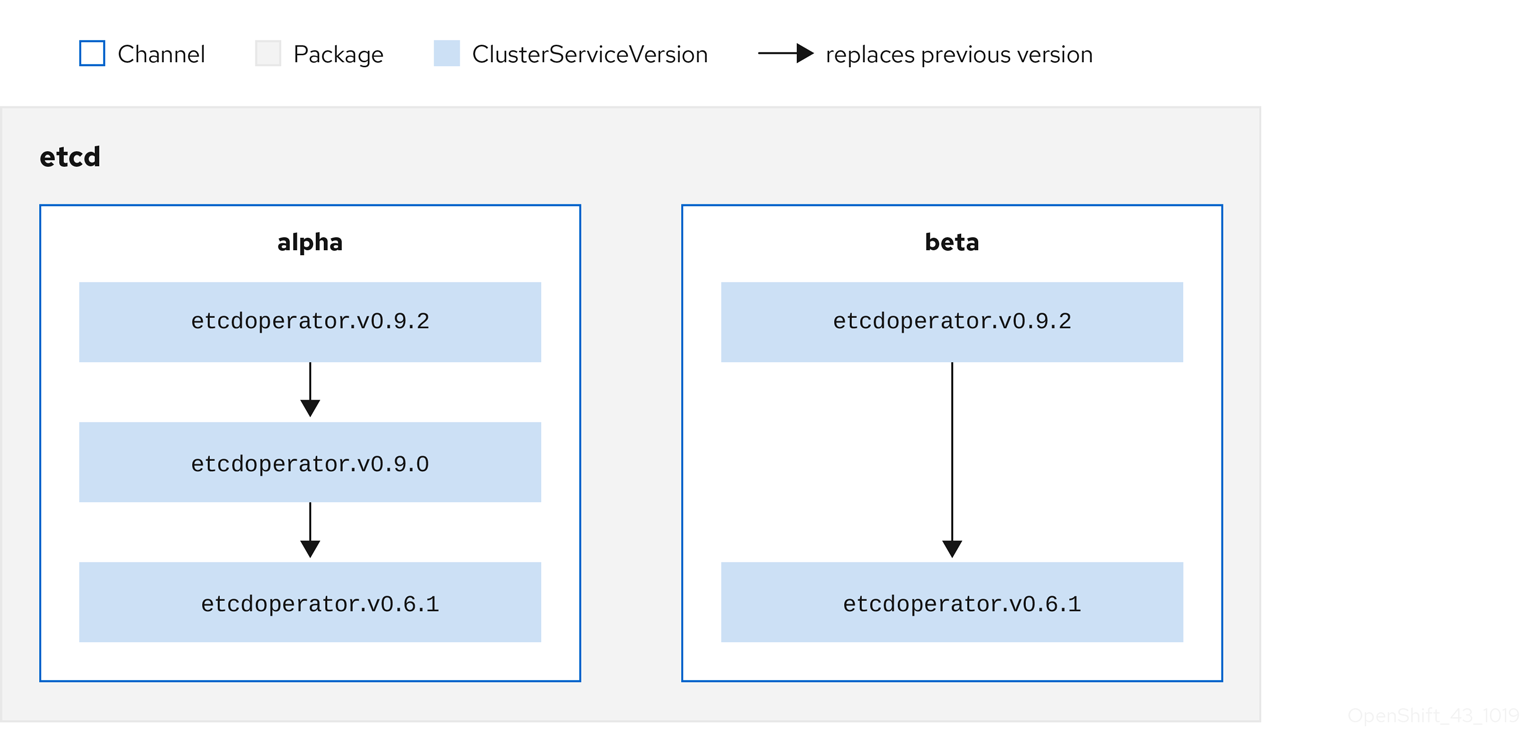

每个 CSV 均有一个 replaces 参数,指明所替换的是哪个 Operator。这样便构建了一个可通过 OLM 查询的 CSV 图,且不同频道之间可共享更新。可将频道视为更新图表的入口点:

图 2.4. OLM 的可用频道更新图表

例如:

软件包中的频道

为了让 OLM 成功查询更新、给定 CatalogSource、软件包、频道和 CSV,目录必须能够明确无误地返回替换输入 CSV 的单个 CSV。

2.1.3.1. 升级路径示例

对于示例升级场景,假设安装的 Operator 对应于 0.1.1 版 CSV。OLM 查询 CatalogSource,并在订阅的频道中检测升级包,新的 0.1.3 版 CSV 取代了旧的但未安装的 0.1.2 版 CSV,后者又取代了更旧的已安装的 0.1.1 版 CSV。

OLM 通过 CSV 中指定的 replaces 字段从频道头倒退至之前的版本,以确定升级路径为 0.1.3 → 0.1.2 → 0.1.1,其中箭头代表前者取代后者。OLM 一次仅升级一个 Operator 版本,直至到达频道头。

对于该给定场景,OLM 会安装 0.1.2 版 Operator 来取代现有的 0.1.1 版 Operator。然后再安装 0.1.3 版 Operator 来取代之前安装的 0.1.2 版 Operator。至此,所安装的 0.1.3 版 Operator 与频道头相匹配,意味着升级已完成。

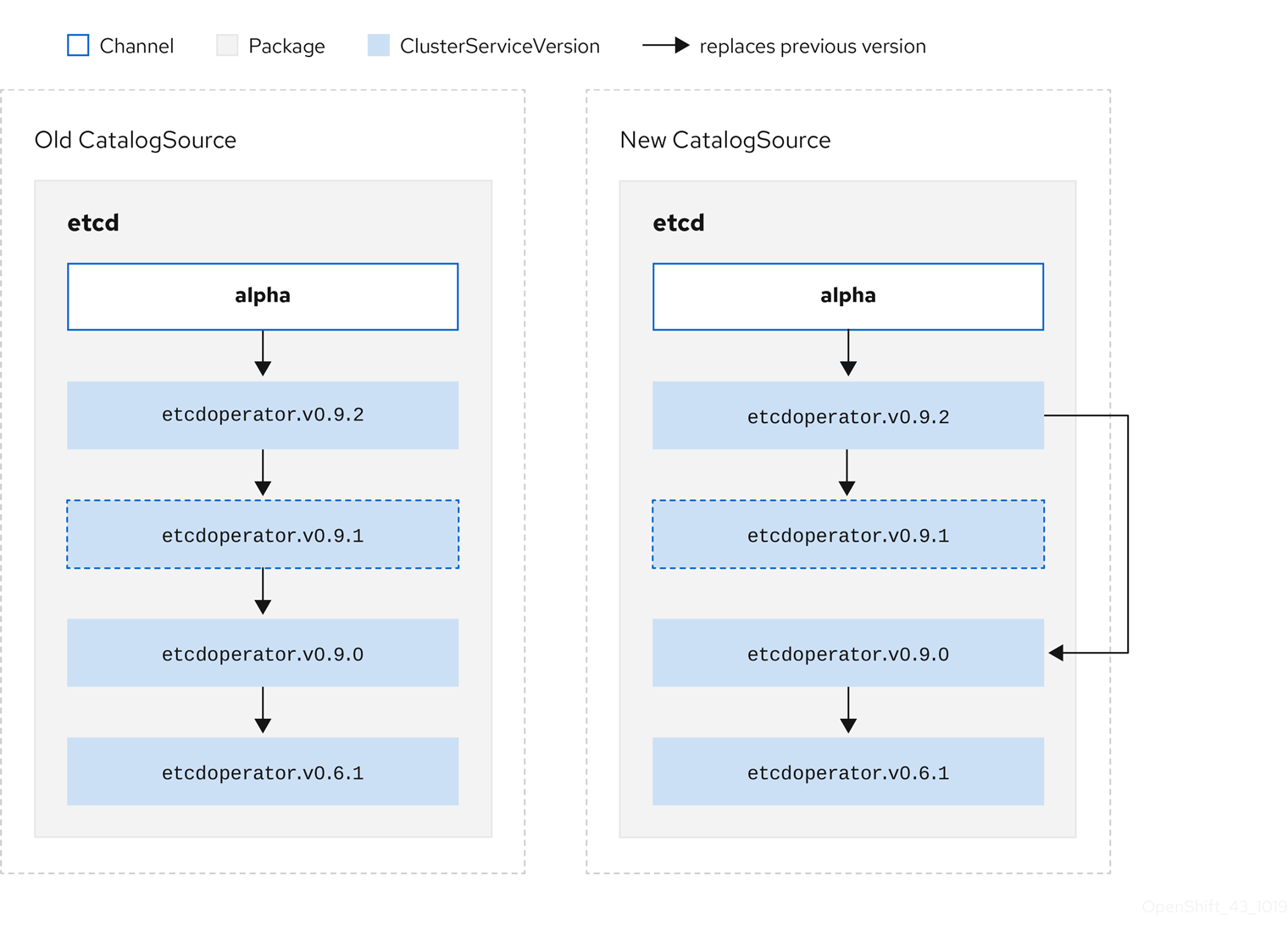

2.1.3.2. 跳过升级

OLM 的基本升级路径如下:

- 通过对 Operator 的一个或多个更新来更新 CatalogSource。

- OLM 会遍历 Operator 的所有版本,直到到达 CatalogSource 包含的最新版本。

但有时这不是一种安全操作。某些情况下,已发布但尚未就绪的 Operator 版本不可安装至集群中,如版本中存在严重漏洞。

这种情况下,OLM 必须考虑两个集群状态,并提供支持这两个状态的更新图:

- 集群发现并安装了“不良”中间 Operator。

- “不良”中间 Operator 尚未安装至集群中。

通过发送新目录并添加跳过的发行版本,可保证无论集群状态如何以及是否发现了不良更新,OLM 总能获得单个唯一更新。

例如:

带有跳过发行版本的 CSV

考虑以下 Old CatalogSource 和 New CatalogSource 示例:

图 2.5. 跳过更新

该图表明:

- Old CatalogSource 中的任何 Operator 在 New CatalogSource 中均有单一替换项。

- New CatalogSource 中的任何 Operator 在 New CatalogSource 中均有单一替换项。

- 如果未曾安装不良更新,将来也绝不会安装。

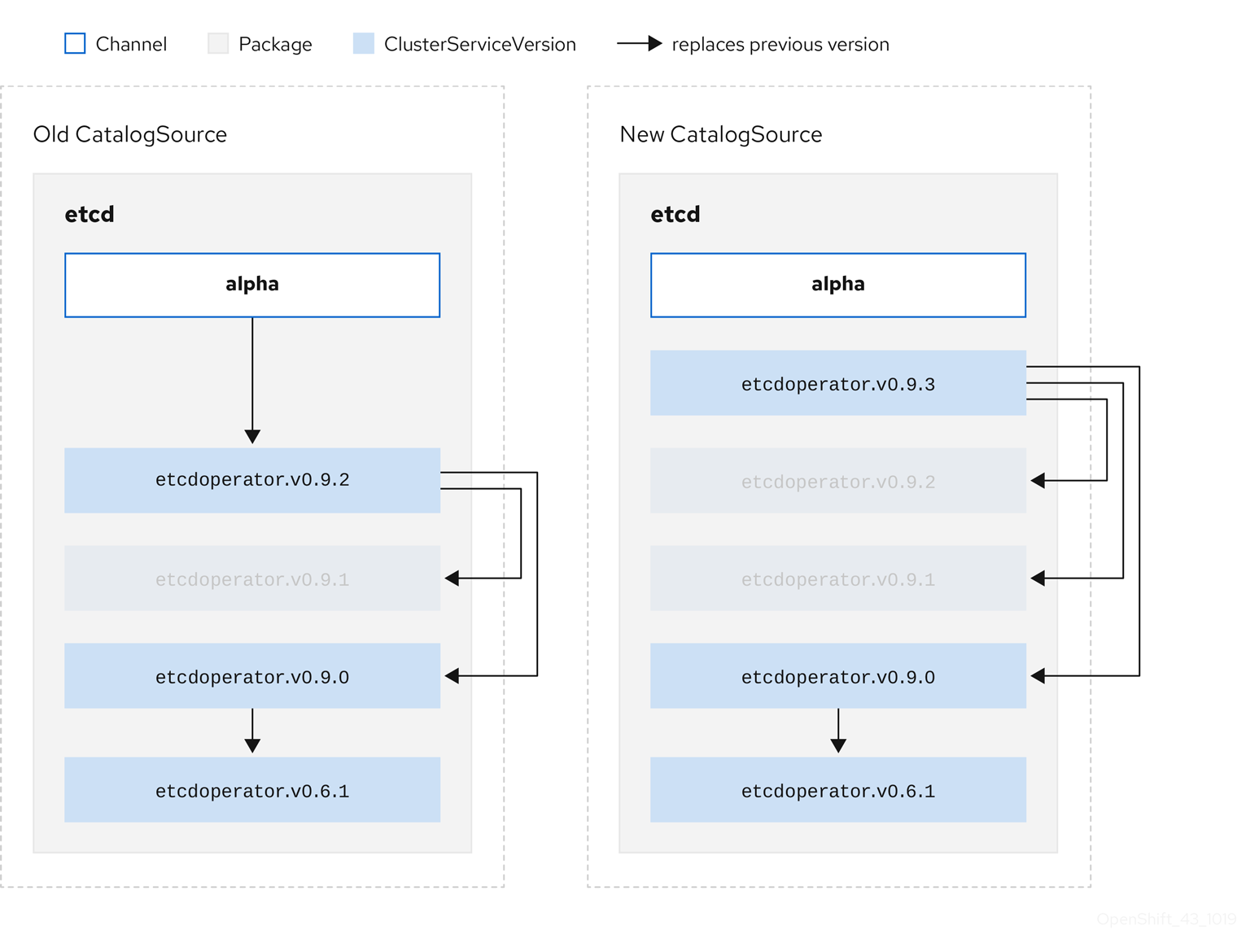

2.1.3.3. 替换多个 Operator

按照描述创建 New CatalogSource 需要发布 CSV 来替换单个 Operator,但可跳过多个。该操作可通过 skipRange 注解来完成:

olm.skipRange: <semver_range>

olm.skipRange: <semver_range>

其中 <semver_range> 具有 semver library 所支持的版本范围格式。

当在目录中搜索更新时,如果某个频道头提供一个 skipRange 注解,且当前安装的 Operator 的版本字段在该范围内,则 OLM 会更新至该频道中的最新条目。

先后顺序:

-

Subscription 上由

sourceName指定的源中的频道头(满足其他跳过条件的情况下)。 -

在

sourceName指定的源中替换当前 Operator 的下一 Operator。 - 对 Subscription 可见的另一个源中的频道头(满足其他跳过条件的情况下)。

- 在对 Subscription 可见的任何源中替换当前 Operator 的下一 Operator。

例如:

附带 skipRange 的 CSV

2.1.3.4. Z-stream 支持

对于相同从版本,z-stream 或补丁版本必须取代所有先前 z-stream 版本。OLM 不关注主版本、从版本或补丁版本,只需要在目录中构建正确图表。

换句话说,OLM 必须能够像在 Old CatalogSource 中一样获取一个图表,像在 New CatalogSource 中一样生成一个图表:

图 2.6. 替换多个 Operator

该图表明:

- Old CatalogSource 中的任何 Operator 在 New CatalogSource 中均有单一替换项。

- New CatalogSource 中的任何 Operator 在 New CatalogSource 中均有单一替换项。

- Old CatalogSource 中的所有 z-stream 版本均会更新至 New CatalogSource 中最新 z-stream 版本。

- 不可用版本可被视为“虚拟”图表节点;它们的内容无需存在,注册表只需像图表看上去这样响应即可。

2.1.4. Operator Lifecycle Manager 架构

Operator Lifecycle Manager 由两个 Operator 组成,分别为:OLM Operator 和 Catalog Operator。

每个 Operator 均负责管理 CRD,而 CRD 是 OLM 的框架基础:

| 资源 | 短名称 | 所有者 | 描述 |

|---|---|---|---|

| ClusterServiceVersion |

| OLM | 应用程序元数据:名称、版本、图标、所需资源、安装等。 |

| InstallPlan |

| Catalog | 为自动安装或升级 CSV 而需创建的资源的计算列表。 |

| CatalogSource |

| Catalog | 定义应用程序的 CSV、CRD 和软件包存储库。 |

| Subscription |

| Catalog | 用于通过跟踪软件包中的频道来保持 CSV 最新。 |

| OperatorGroup |

| OLM | 用于对多个命名空间进行分组,并准备好供 Operator 使用。 |

每个 Operator 还要负责创建资源:

| 资源 | 所有者 |

|---|---|

| 部署 | OLM |

| ServiceAccounts | |

| (Cluster)Roles | |

| (Cluster)RoleBindings | |

| 自定义资源定义 (CRD) | Catalog |

| ClusterServiceVersions (CSV) |

2.1.4.1. OLM Operator

集群中存在 CSV 中指定需要的资源后,OLM Operator 将负责部署由 CSV 资源定义的应用程序。

OLM Operator 不负责创建所需资源;用户可选择使用 CLI 手动创建这些资源,也可选择使用 Catalog Operator 来创建这些资源。这种关注点分离的机制可以使得用户逐渐增加他们选择用于其应用程序的 OLM 框架量。

虽然 OLM Operator 通常被配置为监视所有命名空间,但也可与其他 OLM Operator 一同使用,只要所管理的命名空间不同即可。

OLM Operator 工作流

监视命名空间中的 ClusterServiceVersion (CSV),并检查是否满足要求。如果满足,则运行 CSV 的安装策略。

注意CSV 必须为 OperatorGroup 的活跃成员才可运行该安装策略。

2.1.4.2. Catalog Operator

Catalog Operator 负责解析和安装 CSV 及其指定的所需资源。另外还负责监视频道中的 CatalogSource 中是否有软件包更新,并将其升级(可选择自动)至最新可用版本。

希望跟踪频道中软件包的用户可创建 Subscription 资源,该资源将配置所需软件包、频道和 CatalogSource,以便从中拉取更新。找到更新后,便会代表用户将适当 InstallPlan 写入命名空间。

用户也可直接创建 InstallPlan 资源,其中包含所需 CSV 和批准策略的名称,而 Catalog Operator 会为创建所有所需资源创建一个执行计划。批准后,Catalog Operator 将在 InstallPlan 中创建所有资源;然后单独满足 OLM Operator 的要求,从而继续安装 CSV。

Catalog Operator 工作流

- 拥有 CRD 和 CSV 缓存,按名称索引。

监视是否有用户创建的未解析 InstallPlan:

- 查找与请求名称相匹配的 CSV,并将其添加为已解析的资源。

- 对于每个受管或所需 CRD,将其添加为已解析的资源。

- 对于每个所需 CRD,找到管理相应 CRD 的 CSV。

- 监视是否有已解析的 InstallPlan 并为其创建已发现的所有资源(用户批准或自动)。

- 监视 CatalogSource 和 Subscription,并根据它们创建 InstallPlan。

2.1.4.3. Catalog Registry

Catalog Registry 存储 CSV 和 CRD 以便在集群中创建,并存储有关软件包和频道的元数据。

package manifest 是 Catalog Registry 中的一个条目,用于将软件包标识与 CSV 集相关联。在软件包中,频道指向特定 CSV。因为 CSV 明确引用了所替换的 CSV,软件包清单向 Catalog Operator 提供了将 CSV 更新至频道中最新版本所需的信息,逐步安装和替换每个中间版本。

2.1.5. 公开的指标

Operator Lifecycle Manager (OLM) 会公开某些 OLM 特定资源,供基于 Prometheus 的 OpenShift Container Platform 集群监控堆栈使用。

| 名称 | 描述 |

|---|---|

|

| CatalogSource 的数量。 |

|

|

在协调 ClusterServiceVersion(CSV)时,每当 CSV 版本处于 |

|

| 成功注册的 CSV 数量。 |

|

|

在协调 CSV 时,代表 CSV 版本处于 |

|

| CSV 升级的 Monotonic 计数。 |

|

| InstallPlan 的数量。 |

|

| Subscription 数。 |

|

|

订阅同步的 Monotonic 计数。包括 |

2.2. Operator Lifecycle Manager 依赖项解析

该指南概述了 OpenShift Container Platform 中 Operator Lifecycle Manager (OLM) 内的依赖项解析和自定义资源定义 (CRD) 升级生命周期。

2.2.1. 关于依赖项解析

OLM 管理运行 Operator 的依赖项解析和升级生命周期。在很多方面,OLM 的问题与其他操作系统软件包管理程序类似,比如 yum 和 rpm。

但其中有一个限制是相似系统一般不存在而 OLM 存在的,那就是:因为 Operator 始终在运行,所以 OLM 会努力确保您所接触的 Operator 组始终相互兼容。

这意味着,OLM 绝不会:

- 安装一组系统无法提供其所需 API 的 Operator,或

- 更新某个 Operator 之时导致依赖该 Operator 的另一 Operator 中断。

2.2.2. 升级自定义资源定义 (CRD)

如果自定义资源定义 (CRD) 属于单一 ClusterServiceVersion (CSV),OLM 会立即对其升级。如果某个 CRD 被多个 CSV 拥有,则当该 CRD 满足以下所有向后兼容条件时才会升级:

- 所有已存在于当前 CRD 中的服务版本都包括在新 CRD 中。

- 在对照新 CRD 验证模式进行验证时,与 CRD 的服务版本相关联的所有现有实例或自定义资源 (CR) 均有效。

2.2.2.1. 添加新版 CRD

流程

要添加新版 CRD:

在

versions部分的 CRD 资源中新增一个条目。例如:如果当前 CRD 有一个

v1alpha1版本,而您想新增v1beta1版本,并将其标记为新存储版本:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 新增

v1beta1条目。

如果 CSV 打算使用新版本,请确保已更新您的 CSV

owned部分中的 CRD 引用版本:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 更新

version。

- 将更新的 CRD 和 CSV 推送至您的捆绑包中。

2.2.2.2. 弃用或删除 CRD 版本

OLM 不允许立即删除 CRD 的服务版本。弃用的 CRD 版本应首先通过将 CRD 的 served 字段设置为 false 来禁用。随后在升级 CRD 时便可将非服务版本删除。

流程

要弃用和删除特定 CRD 版本:

将弃用版本标记为非服务版本,表明该版本已不再使用且后续升级时可删除。例如:

versions: - name: v1alpha1 served: false storage: trueversions: - name: v1alpha1 served: false1 storage: trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 设置为

false。

如果要弃用的版本目前为

storage版本,则将该storage版本切换至服务版本。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意要从 CRD 中删除曾是或现在是

storage的特定版本,该版本必须从 CRD 状态下的storedVersion中删除。OLM 一旦检测到某个已存储版本在新 CRD 中不再存在,OLM 将尝试执行这一操作。- 使用以上更改来升级 CRD。

在后续升级周期中,非服务版本可从 CRD 中完全删除。例如:

versions: - name: v1beta1 served: true storage: trueversions: - name: v1beta1 served: true storage: trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

如果该版本已从 CSV 中删除,请确保您的 CSV

owned部分中的 CRD 引用版本会相应更新。

2.2.3. 依赖项解析方案示例

在以下示例中,provider 是指“拥有”某个 CRD 或 APIService 的 Operator。

示例:弃用从属 API

A 和 B 均为 API(如 CRD):

- A 的供应商依赖 B。

- B 的供应商有 Subscription。

- B 的供应商会更新以提供 C,但弃用 B。

结果:

- B 不再有供应商。

- A 不再工作。

这是 OLM 通过升级策略阻止的一个案例。

示例:版本死锁

A 和 B 均为 API:

- A 的供应商需要 B。

- B 的供应商需要 A。

- A 的供应商更新至(提供 A2,需要 B2)并弃用 A。

- B 的供应商更新至(提供 B2,需要 A2)并弃用 B。

如果 OLM 试图在更新 A 的同时不更新 B,或更新 B 的同时不更新 A,则无法升级到新版 Operator,即使可找到新的兼容集也无法更新。

这是 OLM 通过升级策略阻止的另一案例。

2.3. OperatorGroup

该指南概述了 OpenShift Container Platform 中 Operator Lifecycle Manager (OLM) 的 OperatorGroup 使用情况。

2.3.1. 关于 OperatorGroup

OperatorGroup 是一个 OLM 资源,为 OLM 安装的 Operator 提供多租户配置。OperatorGroup 选择目标命名空间,在其中为其成员 Operator 生成所需的 RBAC 访问权限。

这一组目标命名空间通过存储在 ClusterServiceVersion (CSV) 的 olm.targetNamespaces 注解中的以逗号分隔的字符串来提供。该注解应用于成员 Operator 的 CSV 实例,并注入它们的部署中。

2.3.2. OperatorGroup 成员资格

满足以下任一条件,Operator 即可被视为 OperatorGroup 的 member:

- Operator 的 CSV 与 OperatorGroup 存在于同一命名空间中。

- Operator 的 CSV InstallMode 支持 OperatorGroup 所针对的命名空间集。

InstallMode 由 InstallModeType 字段和 Supported 布尔字段组成。CSV 的 spec 可包含由四个不同 InstallModeType 组成的 InstallMode 集:

| InstallModeType | 描述 |

|---|---|

|

| Operator 可以是选择其自有命名空间的 OperatorGroup 的成员。 |

|

| Operator 可以是选择某一个命名空间的 OperatorGroup 的成员。 |

|

| Operator 可以是选择多个命名空间的 OperatorGroup 的成员。 |

|

|

Operator 可以是选择所有命名空间的 OperatorGroup 的成员(目标命名空间集为空字符串 |

如果 CSV 的 spec 省略了 InstallModeType 条目,则该类型将被认为不受支持,除非可通过暗示支持的现有条目推算出其受支持。

2.3.3. 目标命名空间选择

您可以使用 spec.targetNamespaces 参数为 OperatorGroup 显式命名目标命名空间:

您还可以使用带有 spec.selector 参数的标签选择器指定命名空间:

不建议通过 spec.targetNamespaces 列出多个命名空间,或通过 spec.selector 使用标签选择器,因为在以后的版本中可能会取消对 OperatorGroup 中的多个目标命名空间的支持。

如果 spec.targetNamespaces 和 spec.selector 均已定义,则会忽略 spec.selector。另外,您还可省略 spec.selector 和 spec.targetNamespaces,以指定选择所有命名空间的全局 OperatorGroup:

apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: my-group namespace: my-namespace

apiVersion: operators.coreos.com/v1

kind: OperatorGroup

metadata:

name: my-group

namespace: my-namespace

选定命名空间的解析集会显示在 OperatorGroup 的 status.namespaces 参数中。全局 OperatorGroup 的 status.namespace 包含空字符串 (""),而该字符串会向正在使用的 Operator 发出信号,要求其监视所有命名空间。

2.3.4. Operatorgroup CSV 注解

OperatorGroup 的成员 CSV 附有以下注解:

| 注解 | 描述 |

|---|---|

|

| 包含 OperatorGroup 的名称。 |

|

| 包含 OperatorGroup 的命名空间。 |

|

| 包含以逗号分隔的字符串,该字符串列出了 OperatorGroup 的目标命名空间选择。 |

除 olm.targetNamespaces 以外的所有注解均包含在复制的 CSV 中。在复制的 CSV 上省略 olm.targetNamespaces 注解可防止租户之间目标命名空间出现重复。

2.3.5. 所提供的 API 注解

olm.providedAPIs 注解中会显示有关 OperatorGroup 提供了哪些 GroupVersionKinds (GVK) 的信息。该注解值为一个字符串,由用逗号分隔的 <kind>.<version>.<group> 组成。其中包括由 OperatorGroup 的所有活跃成员 CSV 提供的 CRD 和 APIService 的 GVK。

查看以下 OperatorGroup 示例,该 OperatorGroup 带有提供 PackageManifest 资源的单个活跃成员 CSV:

2.3.6. 基于角色的访问控制

创建 OperatorGroup 时,会生成三个 ClusterRole。每个 ClusterRole 均包含一个 AggregationRule,后者设置了 ClusterRoleSelector 以匹配标签,如下所示:

| ClusterRole | 要匹配的标签 |

|---|---|

|

|

|

|

|

|

|

|

|

当 CSV 成为 OperatorGroup 的活跃成员时,只要该 CSV 正在使用 AllNamespaces InstallMode 来监视所有命名空间,且没有因 InterOperatorGroupOwnerConflict 原因处于故障状态,便会生成以下 RBAC 资源。

- 来自 CRD 的每个 API 资源的 ClusterRole

- 来自 APIService 中每个 API 资源的 ClusterRole

- 额外的 Role 和 RoleBinding

| ClusterRole | 设置 |

|---|---|

|

|

聚合标签:

|

|

|

聚合标签:

|

|

|

聚合标签:

|

|

|

聚合标签:

|

| ClusterRole | 设置 |

|---|---|

|

|

聚合标签:

|

|

|

聚合标签:

|

|

|

聚合标签:

|

额外的 Role 和 RoleBinding

-

如果 CSV 精确定义了一个包含

*的目标命名空间,则会针对 CSV 权限字段中定义的每个权限生成一个 ClusterRole 和相应的 ClusterRoleBinding。所有生成的资源均会标上olm.owner: <csv_name>和olm.owner.namespace: <csv_namespace>标签。 -

如果 CSV 没有精确定义一个包含

*的目标命名空间,则 Operator 命名空间中所有带有olm.owner: <csv_name>和olm.owner.namespace: <csv_namespace>标签的 Role 和 RoleBinding 均会被复制到目标命名空间中。

2.3.7. 复制的 CSV

OLM 会在每个 OperatorGroup 的目标命名空间中复制 OperatorGroup 的所有活跃成员 CSV。复制 CSV 的目的在于告诉目标命名空间的用户,特定 Operator 已配置为监视在此创建的资源。复制的 CSV 会复制状态原因,并会更新以匹配其源 CSV 的状态。在集群上创建复制的 CSV 之前,会从这些 CSV 中分离 olm.targetNamespaces 注解。省略目标命名空间选择可避免租户之间存在目标命名空间重复的现象。当所复制的 CSV 的源 CSV 不存在或其源 CSV 所属的 OperatorGroup 不再指向复制的 CSV 命名空间时,将会删除复制的 CSV。

2.3.8. 静态 OperatorGroup

如果 OperatorGroup 的 spec.staticProvidedAPIs 字段设置为 true,则该 OperatorGroup 为静态。这样 OLM 就不会修改 OperatorGroup 的 olm.providedAPIs 注解,因此可以提前设置该注解。如果一组命名空间没有活跃的成员 CSV 来为资源提供 API,而用户想使用 OperatorGroup 来防止命名空间集中发生资源争用,则这一操作十分有用。

下面提供一个使用 something.cool.io/cluster-monitoring: "true" 注解来保护所有命名空间中 Prometheus 资源的 OperatorGroup 的示例:

2.3.9. Operatorgroup 交集

如果两个 OperatorGroup 的目标命名空间集的交集不是空集,且根据 olm.providedAPIs 注解的定义,所提供的 API 集的交集也不是空集,则称这两个 OperatorGroup 的提供的 API 有交集。

一个潜在问题是,提供的 API 有交集的 OperatorGroup 可能在命名空间交集中竞争相同资源。

在检查交集规则时,OperatorGroup 的命名空间始终包含在其所选目标命名空间中。

交集规则

每次活跃成员 CSV 同步时,OLM 均会查询集群,以获取 CSV 的 OperatorGroup 和其他所有 OperatorGroup 之间在所提供的 API 方面的交集。然后 OLM 会检查该交集是否为空集:

如果结果为

true,且 CSV 提供的 API 是 OperatorGroup 提供的 API 的子集:- 继续转变。

如果结果为

true,且 CSV 提供的 API 不是 OperatorGroup 提供的 API 的子集:如果 OperatorGroup 是静态的:

- 则清理属于 CSV 的所有部署。

-

将 CSV 转变为故障状态,状态原因为:

CannotModifyStaticOperatorGroupProvidedAPIs。

如果 OperatorGroup 不是静态的:

-

将 OperatorGroup 的

olm.providedAPIs注解替换为其本身与 CSV 提供的 API 的并集。

-

将 OperatorGroup 的

如果结果为

false,且 CSV 提供的 API 不是 OperatorGroup 提供的 API 的子集:- 则清理属于 CSV 的所有部署。

-

将 CSV 转变为故障状态,状态原因为:

InterOperatorGroupOwnerConflict。

如果结果为

false,且 CSV 提供的 API 是 OperatorGroup 提供的 API 的子集:如果 OperatorGroup 是静态的:

- 则清理属于 CSV 的所有部署。

-

将 CSV 转变为故障状态,状态原因为:

CannotModifyStaticOperatorGroupProvidedAPIs。

如果 OperatorGroup 不是静态的:

-

将 OperatorGroup 的

olm.providedAPIs注解替换为其本身与 CSV 提供的 API 的差集。

-

将 OperatorGroup 的

由 OperatorGroup 造成的故障状态并非终端状态。

每次 OperatorGroup 同步时均会执行以下操作:

- 来自活跃成员 CSV 的提供的 API 集是通过集群计算出来的。注意,复制的 CSV 会被忽略。

-

将集群集与

olm.providedAPIs进行比较,如果olm.providedAPIs包含任何额外 API,则将删除这些 API。 - 在所有命名空间中提供相同 API 的所有 CSV 均会重新排序。这样可向交集组中的冲突 CSV 发送通知,表明可能已通过调整大小或删除冲突的 CSV 解决了冲突。

2.3.10. OperatorGroup 故障排除

成员资格

-

如果一个命名空间中存在多个 OperatorGroup,则在该命名空间中创建的所有 CSV 均会变成故障状态,故障原因为:

TooManyOperatorGroups。一旦命名空间中 OperatorGroup 的数量变成 1,因该原因处于故障状态的 CSV 将转变为等待处理状态。 -

如果 CSV 的 InstallMode 不支持其命名空间中 OperatorGroup 的目标命名空间选择,CSV 将变为故障状态,故障原因为

UnsupportedOperatorGroup。一旦 OperatorGroup 的目标命名空间选择变为受支持的配置,或 CSV 的 InstallMode 经修改后支持 OperatorGroup 的目标命名空间选择,因该原因处于故障状态的 CSV 将转变为等待处理状态。

第 3 章 了解 OperatorHub

本指南主要概述 OperatorHub 的构架。

3.1. OperatorHub 概述

OperatorHub 可通过 OpenShift Container Platform Web 控制台获得,是集群管理员用于发现和安装 Operator 的界面。只需单击一次,即可从其非集群源拉取 Operator,并将其安装和订阅至集群中,为工程团队使用 Operator Lifecycle Manager (OLM) 在部署环境中自助管理产品做好准备。

集群管理员可从划分成以下类别的 OperatorSource 中选择:

| 类别 | 描述 |

|---|---|

| 红帽 Operator | 已由红帽打包并提供的红帽产品。受红帽支持。 |

| 经认证的 Operator | 来自主要独立软件供应商 (ISV) 的产品。红帽与 ISV 合作打包并提供。受 ISV 支持。 |

| 社区 Operator | operator-framework/community-operators GitHub 存储库中由相关代表维护的可选可见软件。无官方支持。 |

| 自定义 Operator | 您自行添加至集群的 Operator。如果您尚未添加任何自定义 Operator,则您的 OperatorHub 上 Web 控制台中便不会出现自定义类别。 |

OperatorHub 内容可每 60 分钟自动刷新一次。

OperatorHub 上的操作员被打包在 OLM 上运行。这包括一个名为 ClusterServiceVersion (CSV) 的 YAML 文件,其中包含安装和安全运行 Operator 所需的所有 CRD 、RBAC 规则、Deployment 和容器镜像。它还包含用户可见的信息,如功能描述和支持的 Kubernetes 版本。

Operator SDK 可以用来协助开发人员打包 Operators 以用于 OLM 和 OperatorHub。如果您有一个您的客户需要访问的商业应用程序,请使用红帽 ISV 合作伙伴门户(connect.redhat.com)提供的认证流程来包含它。

3.2. OperatorHub 架构

OperatorHub UI 组件默认由 openshift-marketplace 命名空间中 OpenShift Container Platform 上的 Marketplace Operator 驱动。

Marketplace Operator 负责管理 OperatorHub 和 OperatorSource 自定义资源定义 (CRD)。

尽管某些 OperatorSource 信息会通过 OperatorHub 用户界面公开,但只有创建自有 Operator 的用户可直接使用这些信息。

虽然 OperatorHub 不再使用 CatalogSourceConfig 资源,但在 OpenShift Container Platform 中仍支持这些资源。

3.2.1. OperatorHub CRD

您可使用 OperatorHub CRD,将集群上 OperatorHub 提供的默认 OperatorSource 的状态更改为启用或禁用。该功能对于在有限网络环境中配置 OpenShift Container Platform 来说非常实用。

OperatorHub 自定义资源示例

3.2.2. OperatorSource CRD

对于各个 Operator,OperatorSource CRD 用于定义用于存储 Operator 包的外部数据存储。

OperatorSource 自定义资源示例

- 1

- 要将数据存储标识为应用程序 registry,请将

type设置为appregistry。 - 2

- 目前,Quay 是 OperatorHub 使用的外部数据存储,因此 Quay.io

appregistry的端点被设置为https://quay.io/cnr。 - 3

- 对于社区 Operator,

registryNamespace会被设置为community-operator。 - 4

- 可选择将

displayName设置为 OperatorHub UI 中显示的 Operator 的名称。 - 5

- 也可选择将

publisher设置为 OperatorHub UI 中显示的发布该 Operator 的个人或机构。

第 4 章 在集群中添加 Operator

本指南指导集群管理员将 Operator 安装至 OpenShift Container Platform 集群并将 Operator 订阅到命名空间。

4.1. 安装来自 OperatorHub 的 Operator

作为集群管理员,您可使用 OpenShift Container Platform Web 控制台或 CLI 安装来自 OperatorHub 的 Operator。然后,您可将 Operator 订阅至一个或多个命名空间,供集群上的开发人员使用。

安装过程中,您必须为 Operator 确定以下初始设置:

- 安装模式

- 选择 All namespaces on the cluster (default) 将 Operator 安装至所有命名空间;或选择单个命名空间(如果可用),仅在选定命名空间中安装 Operator。本例选择 All namespaces… 使 Operator 可供所有用户和项目使用。

- 更新频道

- 如果某个 Operator 可通过多个频道获得,则可任选您想要订阅的频道。例如,要通过 stable 频道部署(如果可用),则从列表中选择这个选项。

- 批准策略

- 您可选择自动或手动更新。如果选择自动更新某个已安装的 Operator,则当相应 Operator 有可用的新版本时,Operator Lifecycle Manager (OLM) 将自动升级该 Operator 的运行实例,而无需人为干预。如果选择手动更新,则当有新版 Operator 可用时,OLM 会创建更新请求。作为集群管理员,您必须手动批准该更新请求,才可将 Operator 更新至新版本。

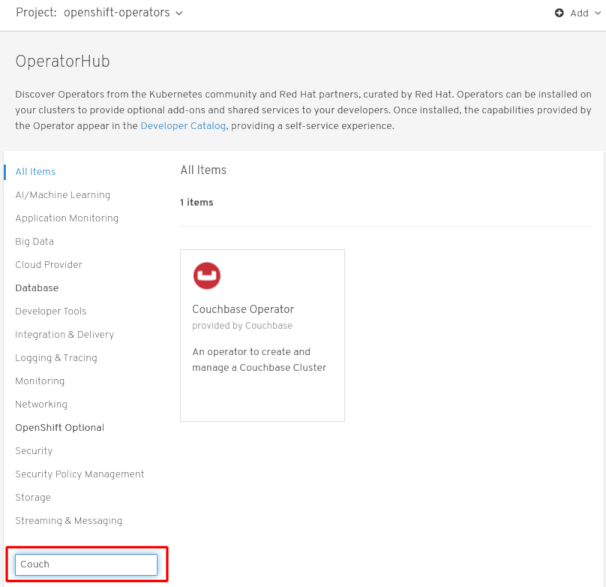

4.1.1. 使用 Web 控制台从 OperatorHub 安装

此流程以 Cuchbase Operator 为例,使用 OpenShift Container Platform Web 控制台从 OperatorHub 安装并订阅 Operator。

先决条件

-

使用具有

cluster-admin权限的账户访问 OpenShift Container Platform 集群。

流程

- 在 Web 控制台中导航至 Operators → OperatorHub 页面。

在 Filter by keyword 方框中滚动或键入关键词(本例中为

Couchbase),以查找所需 Operator。图 4.1. 通过关键词筛选 Operator

- 选定 Operator。对于社区 Operator 来说,系统会提醒您红帽对这类 Operator 不予认证。您必须确认收到该提醒才可继续。这时会显示 Operator 信息。

- 阅读 Operator 信息并单击 Install。

在 Create Operator Subscription 页面:

任选以下一项:

-

All namespaces on the cluster (default),选择该项会将 Operator 安装至默认

openshift-operators命名空间,以便供集群中的所有命名空间监视和使用。该选项并非始终可用。 - A specific namespace on the cluster,该项支持您选择单一特定命名空间来安装 Operator。该 Operator 仅限在该单一命名空间中监视和使用。

-

All namespaces on the cluster (default),选择该项会将 Operator 安装至默认

- 选择一个更新频道(如有多个可用)。

- 如前面所述,选择自动或手动批准策略。

单击 Subscribe,以便该 Operator 可供 OpenShift Container Platform 集群上的所选命名空间使用。

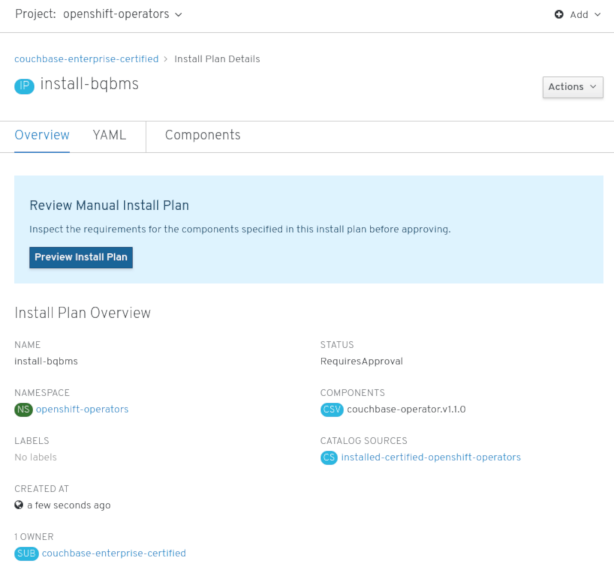

如果选择手动批准策略,则订阅的升级状态将保持正在升级,直至您审核并批准该 Install Plan。

图 4.2. 在 Install Plan 页面手动批准

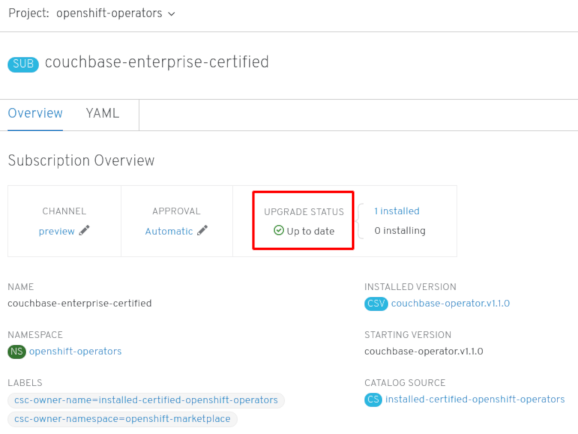

在 Install Plan 页面批准后,订阅的升级状态将变为最新。

如果选择自动批准策略,则升级状态应自动变为最新,而无需人为干预。

图 4.3. 订阅升级状态:最新

当订阅的升级状态变为最新后,选择 Operators → Installed Operators 来验证最终是否出现了 Couchbase ClusterServiceVersion (CSV) 且其 Status 在相关命名空间中最终能否解析为 InstallSucceeded。

注意对于 All namespaces… Installation 模式,状态在

openshift-operators命名空间中解析为 InstallSucceeded,但如果检查其他命名空间,则状态为 Copied。如果没有:

-

检查

openshift-operators项目(如果选择了 A specific namespace… Installation Mode)中的 openshift-operators 项目中的 Pod 的日志,这会在 Workloads → Pods 页面中报告问题以便进一步排除故障。

-

检查

4.1.2. 使用 CLI 从 OperatorHub 安装

您可以使用 CLI 从 OperatorHub 安装 Operator,而不必使用 OpenShift Container Platform Web 控制台。使用 oc 命令来创建或更新订阅对象。

先决条件

-

使用具有

cluster-admin权限的账户访问 OpenShift Container Platform 集群。 - 在您的本地系统安装 oc 命令。

流程

查看 OperatorHub 中集群可用的 Operator 列表。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意适用于您所需 Operator 的 CatalogSource。

检查所需 Operator,以验证其支持的 InstallMode 和可用频道:

oc describe packagemanifests <operator_name> -n openshift-marketplace

$ oc describe packagemanifests <operator_name> -n openshift-marketplaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow OperatorGroup 是一个 OLM 资源用来选择目标命名空间。在这些目标命名空间中生成与 OperatorGroup 相同的命名空间中的所有 Operator 所需的 RBAC 访问。

订阅 Operator 的命名空间必须具有与 Operator 的 InstallMode 相匹配的 OperatorGroup,可采用

AllNamespaces模式,也可采用SingleNamespace模式。如果要安装的 Operator 采用AllNamespaces模式,则表明openshift-operators命名空间中已有适当的 OperatorGroup。如果要安装的 Operator 采用

SingleNamespace模式,而您没有适当的 OperatorGroup,则必须创建一个。注意如果选择

SingleNamespace模式,该流程的 Web 控制台版本会在后台自动为您处理 OperatorGroup 和订阅对象的创建。创建 OperatorGroup 对象 YAML 文件,如

operatorgroup.yaml:OperatorGroup 示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 OperatorGroup 对象:

oc apply -f operatorgroup.yaml

$ oc apply -f operatorgroup.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

创建一个订阅对象 YAML 文件,以便为 Operator 订阅一个命名空间,如

sub.yaml:订阅示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建订阅对象:

oc apply -f sub.yaml

$ oc apply -f sub.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 此时,OLM 已了解所选的 Operator。Operator 的 ClusterServiceVersion (CSV) 应出现在目标命名空间中,由 Operator 提供的 API 应可用于创建。

其他资源

第 5 章 在 Operator Lifecycle Manager 中配置代理支持

如果在 OpenShift Container Platform 集群中配置了全局代理,Operator Lifecycle Manager 会自动配置使用集群范围代理管理的 Operator。但是,您也可以配置已安装的 Operator 来覆盖全局代理服务器或注入自定义 CA 证书。

5.1. 覆盖 Operator 的代理设置

如果配置了集群范围的出口代理,则使用 Operator Lifecycle Manager (OLM) 创建的应用程序会继承其 Deployment 和 Pod 上的集群范围代理设置。集群管理员还可通过配置 Operator 的订阅来覆盖这些代理设置。

先决条件

-

使用具有

cluster-admin权限的账户访问 OpenShift Container Platform 集群。

流程

- 在 Web 控制台中导航至 Operators → OperatorHub 页面。

- 选择 Operator 并点 Install。

在 Create Operator Subscription 页面中,修改 Subscription 对象的 YAML,使其在

spec部分中包含一个或多个以下环境变量 :-

HTTP_PROXY -

HTTPS_PROXY -

NO_PROXY

例如:

带有代理设置的订阅对象覆盖

Copy to Clipboard Copied! Toggle word wrap Toggle overflow OLM 将这些环境变量作为一个单元处理; 如果至少设置了一个环境变量,则所有 3 个变量都将被视为覆盖,并且集群范围的默认值不会用于订阅的 Operator 部署。

-

- 点击 Subscribe 使 Operator 可供选择的命名空间使用。

当 Operator 的 CSV 出现在相关命名空间中后,您可以验证部署中是否设置了自定义代理环境变量。例如,使用 CLI:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

其他资源

- 如需了解在覆盖 Operator 的代理设置时取消设置环境变量的已知问题 BZ#1751903 的详细信息,请参阅 OpenShift Container Platform 4.3 发行注记。

5.2. 注入自定义 CA 证书

当集群管理员使用 ConfigMap 向集群添加自定义 CA 证书时,Cluster Network Operator 会将用户提供的证书和系统 CA 证书合并为一个捆绑包(bundle)。您可以将这个合并捆绑包注入 Operator Lifecycle Manager (OLM) 上运行的 Operator 中,如果您有一个中间人(man-in-the-middle)HTTPS 代理,这将会有用。

先决条件

-

使用具有

cluster-admin权限的账户访问 OpenShift Container Platform 集群。 - 使用 ConfigMap 添加自定义 CA 证书到集群。

- 在 OLM 上安装并运行所需的 Operator。

流程

在存在 Operator 订阅的命名空间中创建一个空 ConfigMap,并包含以下标签:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建此 ConfigMap 后,ConfigMap 会立即被合并捆绑包的证书内容填充。

更新 Operator 的订阅对象,使其包含

spec.config部分,该部分可将trusted-caConfigMap 作为卷挂载到需要自定义 CA 的 Pod 中的各个容器:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 6 章 从集群中删除 Operator

下面介绍如何使用 Web 控制台或 CLI 从集群中删除 Operator。

6.1. 使用 Web 控制台从集群中删除 Operator

集群管理员可以使用 Web 控制台从所选命名空间中删除已安装的 Operator。

先决条件

-

使用具有

cluster-admin权限的账户访问 OpenShift Container Platform 集群 Web 控制台。

流程

- 进入 Operators → Installed Operators 页面,在 Filter by name 字段滚动鼠标或键入关键词,以查找您想要的 Operator。然后点击。

在 Operator Details 页面的右侧,从 Actions 下拉菜单中选择 Uninstall Operator。

此时会显示 Uninstall Operator? 对话框,提醒您移除 Operator 后不会移除任何自定义资源定义或受管资源。如果 Operator 在集群中部署了应用程序,或者配置了非集群资源,则这些应用程序将继续运行,需要手动清理。

此操作移除了 Operator、任何 Operator 部署和 Pod。由 Operator 管理的任何资源(包括 CRD 和 CR)都不会被删除。Web 控制台为一些 Operator 启用仪表板和导航项。要在卸载 Operator 后删除这些,您可能需要手动删除 Operator CRD。

- 选择 Uninstall。此 Operator 将停止运行,并且不再接收更新。

6.2. 使用 CLI 从集群中删除 Operator

集群管理员可以使用 CLI 从所选命名空间中删除已安装的 Operator。

先决条件

-

使用具有

cluster-admin权限的账户访问 OpenShift Container Platform 集群。 -

已在工作站上安装

oc命令。

流程

通过

currentCSV字段检查已订阅 Operator 的当前版本(如jaeger):oc get subscription jaeger -n openshift-operators -o yaml | grep currentCSV currentCSV: jaeger-operator.v1.8.2

$ oc get subscription jaeger -n openshift-operators -o yaml | grep currentCSV currentCSV: jaeger-operator.v1.8.2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 删除 Operator 的订阅(如

Jaeger):oc delete subscription jaeger -n openshift-operators subscription.operators.coreos.com "jaeger" deleted

$ oc delete subscription jaeger -n openshift-operators subscription.operators.coreos.com "jaeger" deletedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用上一步中的

currentCSV值来删除目标命名空间中相应 Operator 的 CSV:oc delete clusterserviceversion jaeger-operator.v1.8.2 -n openshift-operators clusterserviceversion.operators.coreos.com "jaeger-operator.v1.8.2" deleted

$ oc delete clusterserviceversion jaeger-operator.v1.8.2 -n openshift-operators clusterserviceversion.operators.coreos.com "jaeger-operator.v1.8.2" deletedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 7 章 从已安装的 Operator 创建应用程序

本指南向开发人员介绍了如何使用 OpenShift Container Platform Web 控制台从已安装的 Operator 创建应用程序。

7.1. 使用 Operator 创建 etcd 集群

本流程介绍了如何通过由 Operator Lifecycle Manager (OLM) 管理的 etcd Operator 来新建一个 etcd 集群。

先决条件

- OpenShift Container Platform 4.3 集群访问权限

- 管理员已在集群范围内安装了 etcd Operator。

流程

- 针对此流程在 OpenShift Container Platform Web 控制台中新建一个项目。本示例所用项目名为 my-etcd。

导航至 Operators → Installed Operators 页面。由集群管理员安装到集群且可供使用的 Operator 将以 ClusterServiceVersions (CSV) 列表形式显示在此处。CSV 用于启动和管理由 Operator 提供的软件。

提示使用以下命令从 CLI 获得该列表:

oc get csv

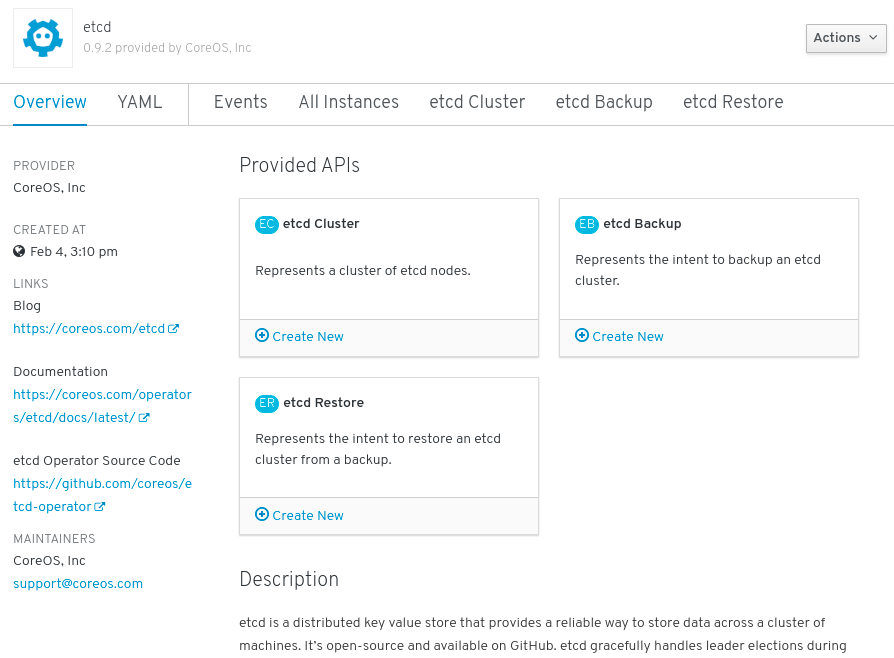

$ oc get csvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 进入 Installed Operators 页面,点击 Copied,然后点击 etcd Operator 查看更多详情和可用操作:

图 7.1. etcd Operator 概述

正如 Provided API 下所示,该 Operator 提供了三类新资源,包括一种用于 etcd Cluster 的资源(

EtcdCluster资源)。这些对象的工作方式类似于内置的原生 Kubernetes 对象(如Deployments或ReplicaSets),但包含特定于管理 etcd 的逻辑。新建 etcd 集群:

- 在 etcd Cluster API 方框中,点击 Create New。

-

在下一页上,您可对

EtcdCluster对象的最小起始模板进行任何修改,比如集群大小。现在,点击 Create 即可完成。点击后即可触发 Operator 启动 Pod、Services 和新 etcd 集群的其他组件。

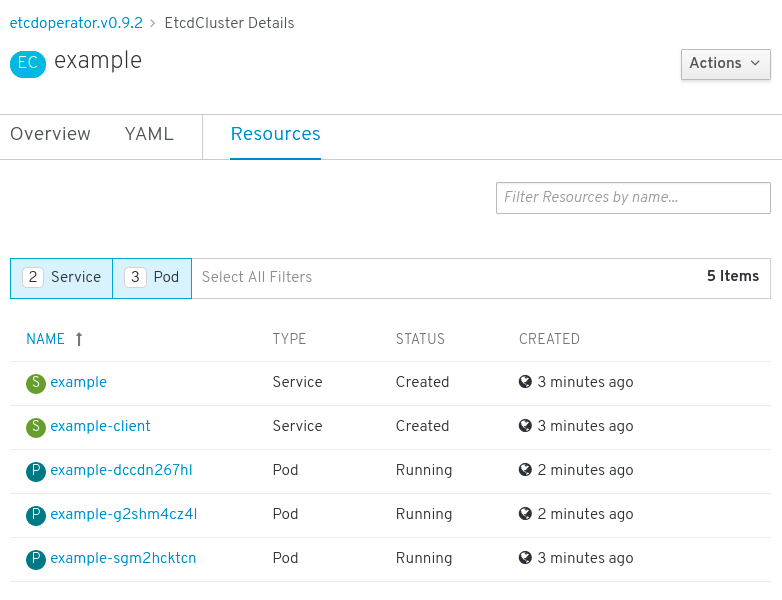

单击 Resources 选项卡,可以看到您的项目现在包含很多由 Operator 自动创建和配置的资源。

图 7.2. etcd Operator 资源

验证已创建了支持您从项目中的其他 Pod 访问数据库的 Kubernetes 服务。

给定项目中具有

edit角色的所有用户均可创建、管理和删除应用程序实例(本例中为 etcd 集群),这些实例由已在项目中创建的 Operator 以自助方式管理,就像云服务一样。如果要赋予其他用户这一权利,项目管理员可使用以下命令添加角色:oc policy add-role-to-user edit <user> -n <target_project>

$ oc policy add-role-to-user edit <user> -n <target_project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

现在您有了一个 etcd 集群,当 Pod 运行不畅,或在集群中的节点之间迁移时,该集群将对故障做出反应并重新平衡数据。最重要的是,具有适当访问权限的集群管理员或开发人员现在可轻松将该数据库用于其应用程序。

第 8 章 查看 Operator 状态

了解 Operator Lifecycle Manager (OLM) 中的系统状态,对于决定和调试已安装 Operator 的问题来说非常重要。OLM 会提供一些有关订阅和相关 CatalogSource 资源的见解,了解它们的状态和所执行的操作。这样有助于用户更好地理解 Operator 的运行状况。

8.1. 状况类型

订阅可报告以下状况类型:

| 状况 | 描述 |

|---|---|

|

| 用于解析的全部或部分 CatalogSource 运行不畅。 |

|

| 订阅的 InstallPlan 缺失。 |

|

| 订阅的 InstallPlan 等待安装。 |

|

| 订阅的 InstallPlan 失败。 |

8.2. 使用 CLI 查看 Operator 状态

可以使用 CLI 来查看 Operator 状态。

流程

使用

oc describe命令检查订阅资源:oc describe sub <subscription_name>

$ oc describe sub <subscription_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在命令输出中找到

Conditions部分:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 9 章 创建 Operator 的安装与升级策略。

Operator 可能需要广泛权限才可运行,且不同版本需要的权限也可能不同。Operator Lifecycle Manager (OLM) 需要 cluster-admin 权限才可运行。默认情况下,Operator 作者可在 ClusterServiceVersion (CSV) 中指定任意权限集,OLM 之后会将其授予 Operator。

集群管理员应采取措施,确保 Operator 无法获得全集群权限,且用户不可使用 OLM 来提升权限。要实现这一目的的一种方法要求集群管理员在将 Operator 添加至集群之前先对其进行审核。集群管理员还可获得一些工具来决定和限制在使用服务账户安装或升级 Operator 期间允许的操作。

通过将 OperatorGroup 与获得一组权限的服务账户相关联,集群管理员便可对 Operator 设定策略,以确保它们仅在预先决定的边界范围内按照 RBAC 规则运行。Operator 无法执行任何这些规则未明确允许的操作。

非集群管理员可自行安装 Operator 但范围有限,这一规定意味着更多 Operator Framework 工具可安全提供给更多用户,为通过 Operator 构建应用程序提供更丰富的体验。

9.1. 了解 Operator 安装策略

通过使用 OLM,集群管理员可选择为一个 OperatorGroup 指定一个服务账户,以便部署与这个 OperatorGroup 相关联的所有 Operator,并按照服务账户获得的权限运行。

APIService 和 CustomResourceDefinition 资源都由 OLM 使用 cluster-admin 角色来创建。不应向与 OperatorGroup 相关联的服务账户授予写入这些资源的权限。

如果指定的服务账户对于正在安装或升级的 Operator 没有足够权限,则会在相应资源状态中添加实用背景信息,以便集群管理员轻松排除故障并解决问题。

与该 OperatorGroup 相关联的所有 Operator 现已被限制在指定服务账户获得的权限范围内。如果 Operator 请求了超出服务账户范围的权限,安装将会失败,并将显示相应错误。

9.1.1. 安装场景

在确定是否可在集群上安装或升级 Operator 时,OLM 会考虑以下情况:

- 集群管理员新建了一个 OperatorGroup 并指定了服务账户。已安装与该 OperatorGroup 相关联的所有 Operator,且这些 Operator 将根据相应服务账户获得的权限运行。

- 集群管理员新建了一个 OperatorGroup 但未指定服务账户。OpenShift Container Platform 保持向后兼容性,因此会保留默认行为,并允许安装和升级 Operator。

- 对于没有指定服务账户的现有 OperatorGroup,会保留默认行为,并允许安装和升级 Operator。

- 集群管理员更新了现有 OperatorGroup 并指定了服务账户。OLM 支持现有 Operator 继续根据当前权限运行。现有 Operator 升级后,它会重新安装并根据相应服务账户获得的权限运行,与新 Operator 一样。

- 由 OperatorGroup 指定的服务账户因添加或删除了某些权限而有所变动,或者现有服务账户被换成了新服务账户。现有 Operator 升级后,它会重新安装并根据更新后的服务账户获得的权限运行,与新 Operator 一样。

- 集群管理员从 OperatorGroup 中删除了服务账户。默认行为保留,并允许安装和升级 Operator。

9.1.2. 安装工作流

当某个 OperatorGroup 关联至某个服务账户,且安装或升级了 Operator 后,OLM 便会使用以下工作流:

- OLM 提取给定订阅对象。

- OLM 获取与该订阅相关联的 OperatorGroup。

- OLM 确定 OperatorGroup 是否已指定服务账户。

- OLM 在服务账户范围内创建一个客户端,并使用该范围内客户端来安装 Operator。这样可确保 OperatorGroup 所请求的任何权限始终处于 OperatorGroup 中服务账户的权限范围内。

- OLM 新建一个服务账户,在 CSV 中指定其权限集,并将其分配至 Operator。Operator 将根据所分配的服务账户运行。

9.2. 限定 Operator 安装范围

要为在 OLM 上安装和升级 Operator 提供范围规则,请将服务账户与 OperatorGroup 相关联。

集群管理员可借鉴本例,将一组 Operator 限制到指定命名空间中。

流程

新建命名空间:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 分配 Operator 的权限范围。这一步涉及新建服务账户、相关角色和角色绑定。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 为简便起见,以下示例授予服务账户在指定命名空间进行任何操作的权限。在生产环境中,应创建更为精细的权限集:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在指定的命名空间中创建一个 OperatorGroup。该 OperatorGroup 以指定的命名空间为目标,以确保其租期仅限于相应命名空间。另外,OperatorGroup 还允许用户指定服务账户。指定上一步创建的 ServiceAccount:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在指定命名空间中安装的任何 Operator 均会关联至该 OperatorGroup,因此也会关联至指定的服务账户。

在指定命名空间中创建订阅以安装 Operator:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 与该 OperatorGroup 相关联的所有 Operator 已被限制在指定服务账户获得的权限范围内。如果 Operator 请求的权限超出服务账户范围,安装将会失败,并将显示相应错误。

9.2.1. 细粒度权限

OLM 使用 OperatorGroup 中指定的服务账户来创建或更新与正在安装的 Operator 相关的以下资源:

- ClusterServiceVersion

- Subscription

- Secret

- ServiceAccount

- Service

- ClusterRole 和 ClusterRoleBinding

- Role 和 RoleBinding

要将 Operator 限制到指定命名空间,集群管理员可以首先向服务账户授予以下权限:

以下角色只是一个通用示例,具体 Operator 可能需要额外规则。

另外,如果任何 Operator 指定了 pull secret,还必须增加以下权限:

- 1

- 需要从 OLM 命名空间中获取 secret。

9.3. 故障排除权限失败

如果因为缺少权限而导致 Operator 安装失败,请按照以下流程找出错误。

流程

查看订阅对象。其状态中有一个指向 InstallPlan 对象的对象引用

installPlanRef,该对象试图为 Operator 创建必要的 [Cluster]Role[Binding]:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查 InstallPlan 对象的状态,了解出现的任何错误:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 错误信息中会显示:

-

创建失败的资源类型,包括资源的 API 组。本例中为

rbac.authorization.k8s.io组中的clusterroles。 - 资源名称。

-

错误类型:

is forbidden表明相应用户没有足够权限来执行这一操作。 - 试图创建或更新资源的用户名称。本例中指的是 OperatorGroup 中指定的服务账户。

操作范围:

集群范围内或范围外。用户可在服务账户中增加所缺权限,然后迭代操作。

注意OLM 目前未提供首次尝试的完整错误列表,但可能会在后续版本中增加。

-

创建失败的资源类型,包括资源的 API 组。本例中为

第 10 章 在受限网络中使用 Operator Lifecycle Manager

如果在受限网络(也被称为断开连接的集群)中安装 OpenShift Container Platform,Operator Lifecycle Manager (OLM) 将不再使用默认的 OperatorHub 源,因为这类源需要足够的网络连接。集群管理员可禁用这些默认源并创建本地镜像,以便 OLM 从本地源安装和管理 Operator。

虽然 OLM 可以从本地源管理 Operator,但给定 Operator 在受限网络中能否成功运行仍取决于 Operator 本身。Operator 必须:

-

在 ClusterServiceVersion (CSV) 对象的

relatedImages参数中列出所有相关的镜像,或 Operator 执行时可能需要的其他容器镜像。 - 通过摘要 (SHA) 而不是标签来引用所有指定的镜像。

如需了解在断开连接的模式模中可以运行的 Operator 列表,请参阅以下红帽知识库文章:

其他资源

10.1. 了解 Operator 目录镜像

Operator Lifecycle Manager (OLM) 始终从 Operator 目录的最新版本安装 Operator。从 OpenShift Container Platform 4.3 开始,红帽提供的 Operator 通过 quay.io 中的 Quay App Registry 目录发布。

| Catalog | 描述 |

|---|---|

|

| 提供由红帽打包并提供的红帽产品的公共目录。受红帽支持。 |

|

| 提供来自主要独立软件供应商(ISV)的产品的公共目录。红帽与 ISV 合作打包并提供。受 ISV 支持。 |

|

| 提供由 operator-framework/community-operators GitHub 存储库中相关代表维护的软件的公共目录。无官方支持。 |

随着目录的更新,Operator 的最新版本会发生变化,旧版本可能会被删除或修改。此行为可能会导致长时间维护可重复生成的安装时出现问题。另外,当 OLM 在受限网络环境中的 OpenShift Container Platform 集群上运行时,它无法直接从 quay.io 访问目录。

使用 oc adm catalog build 命令,集群管理员可创建 Operator 目录镜像。Operator 目录镜像为:

- App Registry 类型目录内容的时间点导出。

- 将 App Registry 目录转换为容器镜像类型目录的结果。

- 不可变工件。

通过创建 Operator 目录镜像,可以在不发生上述问题的情况下简单地使用此内容。

10.2. 构建 Operator 目录镜像

集群管理员可以构建自定义 Operator 目录镜像,供 Operator Lifecycle Manager (OLM) 使用,并将镜像推送到支持 Docker v2-2 的容器镜像 registry。对于受限网络中的集群,此 registry 可以是集群有网络访问权限的 registry,如在受限网络安装过程中创建的镜像 registry。

OpenShift Container Platform 集群的内部 registry 不能用作目标 registry,因为它不支持没有标签的推送,而在镜像(mirrir)过程中需要这个功能。

在这一示例中,流程假定在使用镜像 registry 时可访问您的网络以及互联网。

先决条件

- 具有无限网络访问权限的 Linux 工作站 [1]

-

oc版本 4.3.5+ -

podman1.4.4+ 版 - 访问支持 Docker v2-2 的镜像(mirror)registry

如果您正在使用私有 registry,请将

REG_CREDS环境变量设置为到 registry 凭证的文件路径。例如,对于podmanCLI:REG_CREDS=${XDG_RUNTIME_DIR}/containers/auth.json$ REG_CREDS=${XDG_RUNTIME_DIR}/containers/auth.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果您正在使用 quay.io 帐户可访问的私有命名空间,您必须设置 Quay 身份验证令牌。使用您的 quay.io 凭证对登录 API 发出请求,从而设置用于

--auth-token标志的AUTH_TOKEN环境变量:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

流程

在没有网络访问限制的工作站中,与目标镜像(mirror) registry 进行身份验证:

podman login <registry_host_name>

$ podman login <registry_host_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 还可使用

registry.redhat.io验证,以便在构建期间拉取基础镜像:podman login registry.redhat.io

$ podman login registry.redhat.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 根据 quay.io 中的

redhat-operators目录构建目录镜像,进行标记并将其推送到您的镜像 registry:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 从 App Registry 实例中拉取的机构(命名空间)。

- 2

- 使用与目标 OpenShift Container Platform 集群主版本和次版本匹配的标签,将

--from设置为ose-operator-registry基础镜像。 - 3

- 将

--filter-by-os设置为用于基本镜像的操作系统和架构,该镜像必须与目标 OpenShift Container Platform 集群匹配。有效值是linux/amd64、linux/ppc64le和linux/s390x。 - 4

- 为您的目录镜像命名并包含标签,例如:

v1。 - 5

- 可选:如果需要,指定 registry 凭证文件的位置。

- 6

- 可选:如果您不想为目标 registry 配置信任,请添加

--insecure标志。 - 7

- 可选:如果使用其他不公开的应用程序 registry 目录,则需要指定 Quay 身份验证令牌。

有时红帽目录中会意外引入无效的清单;当发生这种情况时,您可能会看到一些错误:

... INFO[0014] directory dir=/var/folders/st/9cskxqs53ll3wdn434vw4cd80000gn/T/300666084/manifests-829192605 file=4.2 load=package W1114 19:42:37.876180 34665 builder.go:141] error building database: error loading package into db: fuse-camel-k-operator.v7.5.0 specifies replacement that couldn't be found Uploading ... 244.9kB/s

... INFO[0014] directory dir=/var/folders/st/9cskxqs53ll3wdn434vw4cd80000gn/T/300666084/manifests-829192605 file=4.2 load=package W1114 19:42:37.876180 34665 builder.go:141] error building database: error loading package into db: fuse-camel-k-operator.v7.5.0 specifies replacement that couldn't be found Uploading ... 244.9kB/sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 这些错误通常不是致命的,如果所提及 Operator 软件包不包含您计划安装的 Operator 或其依赖项,则可以忽略它们。

10.3. 针对受限网络配置 OperatorHub

集群管理员可以使用自定义 Operator 目录镜像将 OLM 和 OperatorHub 配置为在受限网络环境中使用本地内容。本例中的流程使用之前构建并推送到受支持的 registry 的自定义 redhat-operators 目录镜像。

先决条件

- 具有无限网络访问权限的 Linux 工作站 [1]

- 推送到受支持的 registry 的自定义 Operator 目录镜像

-

oc版本 4.3.5+ -

podman1.4.4+ 版 - 访问支持 Docker v2-2 的镜像(mirror)registry

如果您正在使用私有 registry,请将

REG_CREDS环境变量设置为到 registry 凭证的文件路径。例如,对于podmanCLI:REG_CREDS=${XDG_RUNTIME_DIR}/containers/auth.json$ REG_CREDS=${XDG_RUNTIME_DIR}/containers/auth.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow

流程

通过在 spec 中添加

disableAllDefaultSources: true来禁用默认 OperatorSource:oc patch OperatorHub cluster --type json \ -p '[{"op": "add", "path": "/spec/disableAllDefaultSources", "value": true}]'$ oc patch OperatorHub cluster --type json \ -p '[{"op": "add", "path": "/spec/disableAllDefaultSources", "value": true}]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 该操作将禁用在 OpenShift Container Platform 安装期间默认配置的默认 OperatorSource。

oc adm catalog mirror命令提取自定义 Operator catalog 镜像的内容,以生成镜像(mirror)所需的清单:您可以选择:- 允许该命令的默认行为在生成清单后自动将所有镜像内容镜像到您的镜像 registry 中,或者

-

添加

--manifests-only标志来只生成镜像所需的清单,但并不实际将镜像内容镜像到 registry。这对检查哪些要镜像(mirror)非常有用。如果您只需要部分内容的话,可以对映射列表做出任何修改。然后,您可以使用该文件与oc image mirror命令一起,在以后的步骤中镜像修改的镜像列表。

在没有网络访问限制的工作站中,运行以下命令:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

using database path mapping: /:/tmp/190214037 wrote database to /tmp/190214037 using database at: /tmp/190214037/bundles.db ...

using database path mapping: /:/tmp/190214037 wrote database to /tmp/190214037 using database at: /tmp/190214037/bundles.db1 ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 命令生成的临时数据库。

在运行命令后,会在当前目录中生成

<image_name>-manifests/目录以及以下文件:-

用来定义 ImageContentSourcePolicy 对象的

imageContentSourcePolicy.yaml,它可以将节点配置为在 Operator 清单中存储的镜像(image)引用和镜像 (mirror) 的 registry 间进行转换。 -

mapping.txt文件,在其中包含所有源镜像,并将它们映射到目标 registry。此文件与oc image mirror命令兼容,可用于进一步自定义镜像(mirror)配置。

如果您在上一步中使用

--manifests-only标志,并只想镜像部分内容:将

mapping.txt文件中的镜像列表改为您的规格。如果您不确定要镜像的镜像子集的名称和版本,请使用以下步骤查找:对

oc adm catalog mirror命令生成的临时数据库运行sqlite3工具,以检索与一般搜索查询匹配的镜像列表。输出以后如何编辑mapping.txt文件的帮助信息。例如,要检索与字符串

clusterlogging.4.3类似的镜像列表:echo "select * from related_image \ where operatorbundle_name like 'clusterlogging.4.3%';" \ | sqlite3 -line /tmp/190214037/bundles.db$ echo "select * from related_image \ where operatorbundle_name like 'clusterlogging.4.3%';" \ | sqlite3 -line /tmp/190214037/bundles.db1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 请参阅

oc adm catalog mirror命令的输出结果来查找数据库文件的路径。

输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用上一步的结果来编辑

mapping.txt文件,使其只包含您要镜像的镜像子集。例如,您可以使用前面示例输出中的

image值来找出您的mapping.txt文件中存在以下匹配行:mapping.txt中的匹配镜像映射registry.redhat.io/openshift4/ose-logging-kibana5@sha256:aa4a8b2a00836d0e28aa6497ad90a3c116f135f382d8211e3c55f34fb36dfe61=<registry_host_name>:<port>/openshift4-ose-logging-kibana5:a767c8f0 registry.redhat.io/openshift4/ose-oauth-proxy@sha256:6b4db07f6e6c962fc96473d86c44532c93b146bbefe311d0c348117bf759c506=<registry_host_name>:<port>/openshift4-ose-oauth-proxy:3754ea2b

registry.redhat.io/openshift4/ose-logging-kibana5@sha256:aa4a8b2a00836d0e28aa6497ad90a3c116f135f382d8211e3c55f34fb36dfe61=<registry_host_name>:<port>/openshift4-ose-logging-kibana5:a767c8f0 registry.redhat.io/openshift4/ose-oauth-proxy@sha256:6b4db07f6e6c962fc96473d86c44532c93b146bbefe311d0c348117bf759c506=<registry_host_name>:<port>/openshift4-ose-oauth-proxy:3754ea2bCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在这个示例中,如果您只想镜像这些 image,可以在

mapping.txt文件中删除所有其他条目,仅保留上述两行。

在您的没有网络访问限制的工作站中,使用您修改的

mapping.txt文件,使用oc image mirror命令将镜像镜像到 registry:oc image mirror \ [-a ${REG_CREDS}] \ -f ./redhat-operators-manifests/mapping.txt$ oc image mirror \ [-a ${REG_CREDS}] \ -f ./redhat-operators-manifests/mapping.txtCopy to Clipboard Copied! Toggle word wrap Toggle overflow

应用 ImageContentSourcePolicy:

oc apply -f ./redhat-operators-manifests/imageContentSourcePolicy.yaml

$ oc apply -f ./redhat-operators-manifests/imageContentSourcePolicy.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建一个 CatalogSource 对象来引用您的目录镜像。

按照您的规格修改以下内容,并将它保存为

catalogsource.yaml文件:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定您的自定义 Operator 目录镜像。

使用该文件创建 CatalogSource 对象:

oc create -f catalogsource.yaml

$ oc create -f catalogsource.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

确定成功创建以下资源。

检查 Pod:

oc get pods -n openshift-marketplace

$ oc get pods -n openshift-marketplaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY STATUS RESTARTS AGE my-operator-catalog-6njx6 1/1 Running 0 28s marketplace-operator-d9f549946-96sgr 1/1 Running 0 26h

NAME READY STATUS RESTARTS AGE my-operator-catalog-6njx6 1/1 Running 0 28s marketplace-operator-d9f549946-96sgr 1/1 Running 0 26hCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查 CatalogSource:

oc get catalogsource -n openshift-marketplace

$ oc get catalogsource -n openshift-marketplaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME DISPLAY TYPE PUBLISHER AGE my-operator-catalog My Operator Catalog grpc 5s

NAME DISPLAY TYPE PUBLISHER AGE my-operator-catalog My Operator Catalog grpc 5sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查 PackageManifest:

oc get packagemanifest -n openshift-marketplace

$ oc get packagemanifest -n openshift-marketplaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME CATALOG AGE etcd My Operator Catalog 34s

NAME CATALOG AGE etcd My Operator Catalog 34sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

现在,您可在受限网络 OpenShift Container Platform 集群的 web 控制台中,通过 OperatorHub 安装 Operator。

其他资源

10.4. 更新 Operator 目录镜像

集群管理员将 OperatorHub 配置为使用自定义 Operator 目录镜像后,管理员可通过红帽的 App Registry 目录获得相应的更新,使其 OpenShift Container Platform 集群与最新的 Operator 保持一致。这可以通过构建和推送一个新的 Operator 目录镜像,然后将现有的 CatalogSource 的 spec.image 参数替换为新的镜像摘要。

在本例中,该流程假设已配置了自定义 redhat-operators 目录镜像,以便与 OperatorHub 搭配使用。

先决条件

- 具有无限网络访问权限的 Linux 工作站 [1]

-

oc版本 4.3.5+ -

podman1.4.4+ 版 - 访问支持 Docker v2-2 的镜像(mirror)registry

- OperatorHub 配置为使用自定义目录镜像

如果您正在使用私有 registry,请将

REG_CREDS环境变量设置为到 registry 凭证的文件路径。例如,对于podmanCLI:REG_CREDS=${XDG_RUNTIME_DIR}/containers/auth.json$ REG_CREDS=${XDG_RUNTIME_DIR}/containers/auth.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果您正在使用 quay.io 帐户可访问的私有命名空间,您必须设置 Quay 身份验证令牌。使用您的 quay.io 凭证对登录 API 发出请求,从而设置用于

--auth-token标志的AUTH_TOKEN环境变量:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

流程

在没有网络访问限制的工作站中,与目标镜像(mirror) registry 进行身份验证:

podman login <registry_host_name>

$ podman login <registry_host_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 还可使用

registry.redhat.io验证,以便在构建期间拉取基础镜像:podman login registry.redhat.io

$ podman login registry.redhat.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 根据 quay.io 中的

redhat-operators目录构建一个新的目录镜像,进行标记并将其推送到您的镜像(mirror) registry:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 从 App Registry 实例中拉取的机构(命名空间)。

- 2

- 使用与目标 OpenShift Container Platform 集群主版本和次版本匹配的标签,将

--from设置为ose-operator-registry基础镜像。 - 3

- 将

--filter-by-os设置为用于基本镜像的操作系统和架构,该镜像必须与目标 OpenShift Container Platform 集群匹配。有效值是linux/amd64、linux/ppc64le和linux/s390x。 - 4

- 为您的目录镜像命名并包含一个标签,例如:

v2,因为它是更新的目录。 - 5

- 可选:如果需要,指定 registry 凭证文件的位置。

- 6

- 可选:如果您不想为目标 registry 配置信任,请添加

--insecure标志。 - 7

- 可选:如果使用其他不公开的应用程序 registry 目录,则需要指定 Quay 身份验证令牌。

将目录镜像 (mirror) 到目标 registry。以下

oc adm catalog mirror命令提取自定义 Operator catalog 镜像的内容,以生成镜像 (mirror) 和把镜像(image)镜像 (mirror)到 registry 所需的清单:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 应用新生成的清单:

oc apply -f ./redhat-operators-manifests

$ oc apply -f ./redhat-operators-manifestsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要您可能不需要应用

imageContentSourcePolicy.yaml清单。对文件进行一个diff操作来决定是否需要改变。更新 CatalogSource 对象来引用您的目录镜像。

如果您有此 CatalogSource 的原始

catalogsource.yaml文件:编辑

catalogsource.yaml文件,在spec.image字段中引用新目录镜像 :Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定新 Operator 目录镜像。

使用更新的文件替换 CatalogSource 对象:

oc replace -f catalogsource.yaml

$ oc replace -f catalogsource.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

或者,使用以下命令编辑 CatalogSource,在

spec.image参数中引用您的新目录镜像 :oc edit catalogsource <catalog_source_name> -n openshift-marketplace

$ oc edit catalogsource <catalog_source_name> -n openshift-marketplaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

现在,OpenShift Container Platform 集群上的 OperatorHub 页中应可以提供更新的 Operator。

其他资源

10.5. 测试 Operator 目录镜像。

要验证 Operator 目录镜像内容,您可以将其作为容器运行并查询其 gRPC API。要进一步测试镜像,您可以通过引用 CatalogSource 中的镜像来解析 OLM 订阅。本例中的流程使用之前构建并推送到受支持的 registry 的自定义 redhat-operators 目录镜像。

先决条件

- 推送到受支持的 registry 的自定义 Operator 目录镜像

-

podman1.4.4+ 版 -

oc版本 4.3.5+ - 访问支持 Docker v2-2 的镜像(mirror)registry

-

grpcurl

流程

拉取 Operator 目录镜像:

podman pull <registry_host_name>:<port>/olm/redhat-operators:v1

$ podman pull <registry_host_name>:<port>/olm/redhat-operators:v1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行镜像:

podman run -p 50051:50051 \ -it <registry_host_name>:<port>/olm/redhat-operators:v1$ podman run -p 50051:50051 \ -it <registry_host_name>:<port>/olm/redhat-operators:v1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

grpcurl查询正在运行的镜像中的可用软件包:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在频道中获取最新的 Operator 捆绑包:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 获取镜像摘要:

podman inspect \ --format='{{index .RepoDigests 0}}' \ <registry_host_name>:<port>/olm/redhat-operators:v1 example_registry:5000/olm/redhat-operators@sha256:f73d42950021f9240389f99ddc5b0c7f1b533c054ba344654ff1edaf6bf827e3$ podman inspect \ --format='{{index .RepoDigests 0}}' \ <registry_host_name>:<port>/olm/redhat-operators:v1 example_registry:5000/olm/redhat-operators@sha256:f73d42950021f9240389f99ddc5b0c7f1b533c054ba344654ff1edaf6bf827e3Copy to Clipboard Copied! Toggle word wrap Toggle overflow 假设命名空间

my-ns中存在一个支持您的 Operator 及其依赖项的 OperatorGroup,请使用镜像摘要创建一个 CatalogSource 对象。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建一个可从您的目录镜像解析最新可用

servicemeshoperator及其依赖项的订阅:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 11 章 CRD

11.1. 使用自定义资源定义来扩展 Kubernetes API

本指南描述了集群管理员如何通过创建和管理自定义资源定义 (CRD) 来扩展其 OpenShift Container Platform 集群。

11.1.1. 自定义资源定义

在 Kubernetes API 中,资源是存储某一类 API 对象集的端点。例如:内置 Pod 资源包含 Pod 对象集。

自定义资源定义 (CRD) 对象在集群中定义了一个新的、唯一的对象 Kind,并允许 Kubernetes API 服务器处理其整个生命周期。

自定义资源 (CR) 对象由集群管理员通过集群中已添加的 CRD 创建,并支持所有集群用户在项目中增加新的资源类型。

当集群管理员增加新 CRD 至集群中时,Kubernetes API 服务器的回应方式是新建一个可由整个集群或单个项目(命名空间)访问的 RESTful 资源路径,并开始服务于指定的 CR。

集群管理员如果要向其他用户授予 CRD 访问权限,可使用集群角色聚合来向用户授予 admin、edit 或 view 默认集群角色访问权限。集群角色聚合支持将自定义策略规则插入到这些集群角色中。这一行为会将新资源整合至集群的 RBAC 策略中,就像内置资源一样。

Operator 会通过将 CRD 与任何所需 RBAC 策略和其他软件特定逻辑打包到一起来利用 CRD。集群管理员还可手动将 CRD 添加至 Operator 生命周期之外的集群中,供所有用户使用。

虽然只有集群管理员可创建 CRD,但具有 CRD 读写权限的开发人员也可通过现有 CRD 来创建 CR。

11.1.2. 创建自定义资源定义

要创建自定义资源 (CR) 对象,集群管理员首先必须创建一个自定义资源定义 (CRD)。

先决条件

-

以

cluster-admin用户身份访问 OpenShift Container Platform 集群。

流程

要创建 CRD:

先创建一个包含以下字段类型的 YAML 文件:

CRD 的 YAML 文件示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 使用

apiextensions.k8s.io/v1beta1API。 - 2

- 为定义指定名称。名称必须采用 <plural-name>.<group> 格式,并使用来自

group和plural字段的值。 - 3

- 为 API 指定组名。API 组是一个逻辑上相关的对象集。例如,

Job或ScheduledJob等所有批处理对象,均可添加至批处理 API 组 (如 batch.api.example.com) 中。最好使用组织的完全限定域名。 - 4

- 指定 URL 中要用的版本名称。每个 API 组均可能存在于多个版本中。例如:

v1alpha、v1beta、v1。 - 5

- 指定自定义对象可用于某一个项目 (

Namespaced) 还是集群中的所有项目 (Cluster)。 - 6

- 指定 URL 中要用的复数名称。

plural字段与 API URL 网址中的资源相同。 - 7

- 指定将在 CLI 上用作别名并用于显示的单数名称。

- 8

- 指定可创建的对象类型。类型可以采用 CamelCase。

- 9

- 指定与 CLI 中的资源相匹配的较短字符串。

注意默认情况下,CRD 的覆盖范围为整个集群,适用于所有项目。

创建 CRD 对象:

oc create -f <file_name>.yaml

$ oc create -f <file_name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在以下位置新建一个 RESTful API 端点:

/apis/<spec:group>/<spec:version>/<scope>/*/<names-plural>/...

/apis/<spec:group>/<spec:version>/<scope>/*/<names-plural>/...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如,以下端点便是通过示例文件创建的:

/apis/stable.example.com/v1/namespaces/*/crontabs/...

/apis/stable.example.com/v1/namespaces/*/crontabs/...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 现在,您即可使用该端点 URL 来创建和管理 CR。对象

Kind基于您所创建的 CRD 对象的spec.kind字段。

11.1.3. 为自定义资源定义创建集群角色

集群管理员可向现有集群范围的自定义资源定义 (CRD) 授予权限。如果使用 admin、edit 和 view 默认集群角色,请利用集群角色聚合来制定规则。

您必须为每个角色明确分配权限。权限更多的角色不会继承权限较少角色的规则。如果要为某个角色分配规则,还必须将该操作动词分配给具有更多权限的角色。例如,如果要向 view 角色授予 get crontabs 的权限,也必须向 edit 和 admin 角色授予该权限。admin 或 edit 角色通常会分配给通过项目模板创建项目的用户。

先决条件

- 创建 CRD。

流程

为 CRD 创建集群角色定义文件。集群角色定义是一个 YAML 文件,其中包含适用于各个集群角色的规则。OpenShift Container Platform 控制器会将您指定的规则添加至默认集群角色中。

集群角色定义的 YAML 文件示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建集群角色:

oc create -f <file_name>.yaml

$ oc create -f <file_name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

11.1.4. 通过文件创建自定义资源

将自定义资源定义 (CRD) 添加至集群后,可使用 CLI 按照自定义资源 (CR) 规范通过文件创建 CR。

先决条件

- 集群管理员已将 CRD 添加至集群中。

流程

为 CR 创建 YAML 文件。在下面的定义示例中,

cronSpec和image自定义字段在Kind: CronTab的 CR 中设定。Kind来自 CRD 对象的spec.kind字段。CR 的 YAML 文件示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建完文件后,再创建对象:

oc create -f <file_name>.yaml

$ oc create -f <file_name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

11.1.5. 检查自定义资源

您可使用 CLI 检查集群中存在的自定义资源 (CR) 对象。

先决条件

- 您有权访问的命名空间中已存在 CR 对象。

流程

要获得特定

Kind的 CR 的信息,请运行:oc get <kind>

$ oc get <kind>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

oc get crontab NAME KIND my-new-cron-object CronTab.v1.stable.example.com

$ oc get crontab NAME KIND my-new-cron-object CronTab.v1.stable.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 资源名称不区分大小写,您既可使用 CRD 中定义的单数或复数形式,也可使用简称。例如:

oc get crontabs oc get crontab oc get ct

$ oc get crontabs $ oc get crontab $ oc get ctCopy to Clipboard Copied! Toggle word wrap Toggle overflow 还可查看 CR 的原始 YAML 数据:

oc get <kind> -o yaml

$ oc get <kind> -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow

11.2. 管理自定义资源定义中的资源

本指南向开发人员介绍了如何管理来自自定义资源定义 (CRD) 的自定义资源 (CR)。

11.2.1. 自定义资源定义

在 Kubernetes API 中,资源是存储某一类 API 对象集的端点。例如:内置 Pod 资源包含 Pod 对象集。

自定义资源定义 (CRD) 对象在集群中定义了一个新的、唯一的对象 Kind,并允许 Kubernetes API 服务器处理其整个生命周期。

自定义资源 (CR) 对象由集群管理员通过集群中已添加的 CRD 创建,并支持所有集群用户在项目中增加新的资源类型。

Operator 会通过将 CRD 与任何所需 RBAC 策略和其他软件特定逻辑打包到一起来利用 CRD。集群管理员还可手动将 CRD 添加至 Operator 生命周期之外的集群中,供所有用户使用。

虽然只有集群管理员可创建 CRD,但具有 CRD 读写权限的开发人员也可通过现有 CRD 来创建 CR。

11.2.2. 通过文件创建自定义资源

将自定义资源定义 (CRD) 添加至集群后,可使用 CLI 按照自定义资源 (CR) 规范通过文件创建 CR。

先决条件

- 集群管理员已将 CRD 添加至集群中。

流程

为 CR 创建 YAML 文件。在下面的定义示例中,

cronSpec和image自定义字段在Kind: CronTab的 CR 中设定。Kind来自 CRD 对象的spec.kind字段。CR 的 YAML 文件示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建完文件后,再创建对象:

oc create -f <file_name>.yaml

$ oc create -f <file_name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

11.2.3. 检查自定义资源

您可使用 CLI 检查集群中存在的自定义资源 (CR) 对象。

先决条件

- 您有权访问的命名空间中已存在 CR 对象。

流程

要获得特定

Kind的 CR 的信息,请运行:oc get <kind>

$ oc get <kind>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

oc get crontab NAME KIND my-new-cron-object CronTab.v1.stable.example.com

$ oc get crontab NAME KIND my-new-cron-object CronTab.v1.stable.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 资源名称不区分大小写,您既可使用 CRD 中定义的单数或复数形式,也可使用简称。例如:

oc get crontabs oc get crontab oc get ct

$ oc get crontabs $ oc get crontab $ oc get ctCopy to Clipboard Copied! Toggle word wrap Toggle overflow 还可查看 CR 的原始 YAML 数据:

oc get <kind> -o yaml

$ oc get <kind> -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 12 章 Operator SDK

12.1. Operator SDK 入门

本指南将介绍 Operator SDK 的基础知识,指导可作为集群管理员访问基于 Kubernetes 的集群(如 OpenShift Container Platform)的 Operator 作者构建简单 Go-based Memcached Operator 的示例,并管理从安装到升级的整个生命周期。

通过以下两个 Operator Framework 核心组件便可实现这一目的:Operator SDK(operator-sdk CLI 工具和 controller-runtime 库 API)以及 Operator Lifecycle Manager (OLM)。

OpenShift Container Platform 4.3 支持 Operator SDK v0.12.0 或更高版本。

12.1.1. Operator SDK 构架

Operator Framework 是一个开源工具包,用于以有效、自动化且可扩展的方式管理 Kubernetes 原生应用程序,即 Operator。Operator 利用 Kubernetes 的可扩展性来展现云服务的自动化优势,如置备、扩展以及备份和恢复,同时能够在 Kubernetes 可运行的任何地方运行。

Operator 有助于简化对 Kubernetes 上的复杂、有状态的应用程序的管理。然而,现在编写 Operator 并不容易,会面临一些挑战,如使用低级别 API、编写样板文件以及缺乏模块化功能(这会导致重复工作)。

Operator SDK 是一个框架,通过提供以下内容来降低 Operator 的编写难度:

- 高级 API 和抽象,用于更直观地编写操作逻辑

- 支架和代码生成工具,用于快速引导新项目

- 扩展项,覆盖常见的 Operator 用例

12.1.1.1. 工作流

Operator SDK 提供以下工作流来开发新的 Operator:

- 使用 Operator SDK 命令行界面 (CLI) 新建一个 Operator 项目。

- 通过添加自定义资源定义 (CRD) 来定义新的资源 API。

- 使用 Operator SDK API 来指定要监视的资源。

- 在指定的处理程序中定义 Operator 协调逻辑,并使用 Operator SDK API 与资源交互。

- 使用 Operator SDK CLI 来构建和生成 Operator 部署清单。

图 12.1. Operator SDK 工作流

在高级别上,使用了 Operator SDK 的 Operator 会在 Operator 作者定义的处理程序中处理与被监视资源相关的事件,并采取措施协调应用程序的状态。

12.1.1.2. 管理器文件

Operator 的主要程序为 cmd/manager/main.go 中的管理器文件。管理器会自动注册 pkg/apis/ 下定义的所有自定义资源 (CR) 的方案,并运行 pkg/controller/ 下的所有控制器。

管理器可限制所有控制器监视资源的命名空间:

mgr, err := manager.New(cfg, manager.Options{Namespace: namespace})

mgr, err := manager.New(cfg, manager.Options{Namespace: namespace})默认情况下,这是 Operator 运行时所处的命名空间。要监视所有命名空间,把命名空间选项设为空:

mgr, err := manager.New(cfg, manager.Options{Namespace: ""})

mgr, err := manager.New(cfg, manager.Options{Namespace: ""})12.1.1.3. Prometheus Operator 支持

Prometheus 是一个开源系统监视和警报工具包。Prometheus Operator 会创建、配置和管理在基于 Kubernetes 的集群(如 OpenShift Container Platform)中运行的 Prometheus 集群。

默认情况下,Operator SDK 中包括帮助函数,用于在任何生成的 Go-based Operator 中自动设置指标,以便在部署了 Prometheus Operator 的集群上使用。

12.1.2. 安装 Operator SDK CLI

Operator SDK 配有一个 CLI 工具,可协助开发人员创建、构建和部署新的 Operator 项目。您可在工作站上安装 SDK CLI,为编写您自己的 Operator 做准备。

12.1.2.1. 从 GitHub 版本安装

您可从 GitHub 上的项目下载并安装 SDK CLI 的预构建发行版文件。

先决条件

- Go v1.13+

-

dockerv17.03+、podmanv1.2.0+ 或buildahv1.7+ -

已安装 OpenShift CLI (

oc) v4.3+ - 访问基于 Kubernetes v1.12.0+ 的集群

- 访问容器 registry

流程

设置发行版本变量:

RELEASE_VERSION=v0.12.0

RELEASE_VERSION=v0.12.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 下载发行版二进制文件。

Linux:

curl -OJL https://github.com/operator-framework/operator-sdk/releases/download/${RELEASE_VERSION}/operator-sdk-${RELEASE_VERSION}-x86_64-linux-gnu$ curl -OJL https://github.com/operator-framework/operator-sdk/releases/download/${RELEASE_VERSION}/operator-sdk-${RELEASE_VERSION}-x86_64-linux-gnuCopy to Clipboard Copied! Toggle word wrap Toggle overflow macOS:

curl -OJL https://github.com/operator-framework/operator-sdk/releases/download/${RELEASE_VERSION}/operator-sdk-${RELEASE_VERSION}-x86_64-apple-darwin$ curl -OJL https://github.com/operator-framework/operator-sdk/releases/download/${RELEASE_VERSION}/operator-sdk-${RELEASE_VERSION}-x86_64-apple-darwinCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证所下载的发行版本二进制文件。

下载所提供的 ASC 文件。

Linux:

curl -OJL https://github.com/operator-framework/operator-sdk/releases/download/${RELEASE_VERSION}/operator-sdk-${RELEASE_VERSION}-x86_64-linux-gnu.asc$ curl -OJL https://github.com/operator-framework/operator-sdk/releases/download/${RELEASE_VERSION}/operator-sdk-${RELEASE_VERSION}-x86_64-linux-gnu.ascCopy to Clipboard Copied! Toggle word wrap Toggle overflow macOS:

curl -OJL https://github.com/operator-framework/operator-sdk/releases/download/${RELEASE_VERSION}/operator-sdk-${RELEASE_VERSION}-x86_64-apple-darwin.asc$ curl -OJL https://github.com/operator-framework/operator-sdk/releases/download/${RELEASE_VERSION}/operator-sdk-${RELEASE_VERSION}-x86_64-apple-darwin.ascCopy to Clipboard Copied! Toggle word wrap Toggle overflow

将二进制文件与对应的 ASC 文件放在同一个目录中,并运行以下命令来验证该二进制文件:

Linux:

gpg --verify operator-sdk-${RELEASE_VERSION}-x86_64-linux-gnu.asc$ gpg --verify operator-sdk-${RELEASE_VERSION}-x86_64-linux-gnu.ascCopy to Clipboard Copied! Toggle word wrap Toggle overflow macOS:

gpg --verify operator-sdk-${RELEASE_VERSION}-x86_64-apple-darwin.asc$ gpg --verify operator-sdk-${RELEASE_VERSION}-x86_64-apple-darwin.ascCopy to Clipboard Copied! Toggle word wrap Toggle overflow

如果您的工作站上没有维护人员公钥,则会出现以下错误:

gpg --verify operator-sdk-${RELEASE_VERSION}-x86_64-apple-darwin.asc gpg: assuming signed data in 'operator-sdk-${RELEASE_VERSION}-x86_64-apple-darwin' gpg: Signature made Fri Apr 5 20:03:22 2019 CEST gpg: using RSA key <key_id> gpg: Can't check signature: No public key$ gpg --verify operator-sdk-${RELEASE_VERSION}-x86_64-apple-darwin.asc $ gpg: assuming signed data in 'operator-sdk-${RELEASE_VERSION}-x86_64-apple-darwin' $ gpg: Signature made Fri Apr 5 20:03:22 2019 CEST $ gpg: using RSA key <key_id>1 $ gpg: Can't check signature: No public keyCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- RSA 密钥字符串。

要下载密钥,请运行以下命令,用上一条命令输出的 RSA 密钥字符串来替换

<key_id>:gpg [--keyserver keys.gnupg.net] --recv-key "<key_id>"

$ gpg [--keyserver keys.gnupg.net] --recv-key "<key_id>"1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 如果您尚未配置密钥服务器,请使用

--keyserver选项指定一个密钥服务器。

在您的

PATH中安装发行版本二进制文件:Linux:

chmod +x operator-sdk-${RELEASE_VERSION}-x86_64-linux-gnu sudo cp operator-sdk-${RELEASE_VERSION}-x86_64-linux-gnu /usr/local/bin/operator-sdk rm operator-sdk-${RELEASE_VERSION}-x86_64-linux-gnu$ chmod +x operator-sdk-${RELEASE_VERSION}-x86_64-linux-gnu $ sudo cp operator-sdk-${RELEASE_VERSION}-x86_64-linux-gnu /usr/local/bin/operator-sdk $ rm operator-sdk-${RELEASE_VERSION}-x86_64-linux-gnuCopy to Clipboard Copied! Toggle word wrap Toggle overflow macOS:

chmod +x operator-sdk-${RELEASE_VERSION}-x86_64-apple-darwin sudo cp operator-sdk-${RELEASE_VERSION}-x86_64-apple-darwin /usr/local/bin/operator-sdk rm operator-sdk-${RELEASE_VERSION}-x86_64-apple-darwin$ chmod +x operator-sdk-${RELEASE_VERSION}-x86_64-apple-darwin $ sudo cp operator-sdk-${RELEASE_VERSION}-x86_64-apple-darwin /usr/local/bin/operator-sdk $ rm operator-sdk-${RELEASE_VERSION}-x86_64-apple-darwinCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证是否已正确安装 CLI 工具:

operator-sdk version

$ operator-sdk versionCopy to Clipboard Copied! Toggle word wrap Toggle overflow

12.1.2.2. 通过 Homebrew 安装

可使用 Homebrew 来安装 SDK CLI。

先决条件

- Homebrew

-

dockerv17.03+、podmanv1.2.0+ 或buildahv1.7+ -

已安装 OpenShift CLI (

oc) v4.3+ - 访问基于 Kubernetes v1.12.0+ 的集群

- 访问容器 registry

流程

使用

brew命令安装 SDK CLI:brew install operator-sdk

$ brew install operator-sdkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证是否已正确安装 CLI 工具:

operator-sdk version

$ operator-sdk versionCopy to Clipboard Copied! Toggle word wrap Toggle overflow

12.1.2.3. 通过源代码编译并安装

可获取 Operator SDK 源代码来编译和安装 SDK CLI。

先决条件

流程

克隆

operator-sdk存储库:mkdir -p $GOPATH/src/github.com/operator-framework cd $GOPATH/src/github.com/operator-framework git clone https://github.com/operator-framework/operator-sdk cd operator-sdk

$ mkdir -p $GOPATH/src/github.com/operator-framework $ cd $GOPATH/src/github.com/operator-framework $ git clone https://github.com/operator-framework/operator-sdk $ cd operator-sdkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查所需的发行版本分支:

git checkout master

$ git checkout masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 编译并安装 SDK CLI:

make dep make install

$ make dep $ make installCopy to Clipboard Copied! Toggle word wrap Toggle overflow 该操作会在 $GOPATH/bin 中安装 CLI 二进制

operator-sdk。验证是否已正确安装 CLI 工具:

operator-sdk version

$ operator-sdk versionCopy to Clipboard Copied! Toggle word wrap Toggle overflow

12.1.3. 使用 Operator SDK 来构建 Go-based Memcached Operator

Operator SDK 可简化 Kubernetes 原生应用程序的构建,构建该应用程序原本需要深入掌握特定于应用程序的操作知识。SDK 不仅降低了这一障碍,而且有助于减少许多常见管理功能(如计量或监控)所需的样板代码量。

本流程介绍了一个使用 SDK 提供的工具和库构建简单 Memcached Operator 的示例。

先决条件

- 开发工作站已安装 Operator SDK CLI

-

基于 Kubernetes 的集群(v1.8 或更高版本,支持

apps/v1beta2API 组,如 OpenShift Container Platform 4.3)上已安装 Operator Lifecycle Manager (OLM) -

使用具有

cluster-admin权限的账户访问该集群 -

已安装 OpenShift CLI (

oc) v4.1+

流程

创建一个新项目。

使用 CLI 来新建

memcached-operator项目:mkdir -p $GOPATH/src/github.com/example-inc/ cd $GOPATH/src/github.com/example-inc/ operator-sdk new memcached-operator cd memcached-operator

$ mkdir -p $GOPATH/src/github.com/example-inc/ $ cd $GOPATH/src/github.com/example-inc/ $ operator-sdk new memcached-operator $ cd memcached-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 添加新的自定义资源定义 (CRD)。

使用 CLI 来添加名为

Memcached的新 CRD API,将APIVersion设置为cache.example.com/v1apha1,将Kind设置为Memcached:operator-sdk add api \ --api-version=cache.example.com/v1alpha1 \ --kind=Memcached$ operator-sdk add api \ --api-version=cache.example.com/v1alpha1 \ --kind=MemcachedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 这样会将 Memcached 资源 API 构建至

pkg/apis/cache/v1alpha1/下。修改

pkg/apis/cache/v1alpha1/memcached_types.go文件中Memcached自定义资源 (CR) 的 spec 和状态:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 修改好

*_types.go文件后,务必要运行以下命令来更新该资源类型的生成代码:operator-sdk generate k8s

$ operator-sdk generate k8sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

可选:将自定义验证添加到 CRD 中。

当生成清单时,OpenAPI v3.0 模式会添加到

spec.validation块中的 CRD 清单中。此验证块允许 Kubernetes 在 Memcached CR 创建或更新时验证其中的属性。另外,还会生成

pkg/apis/<group>/<version>/zz_generated.openapi.go文件。如果+k8s:openapi-gen=true annotation位于默认存在的Kind类型声明之上,则该文件包含此验证块的 Go 表示。这一自动生成的代码是 GoKind类型的 OpenAPI 模型,您可以从中创建完整的 OpenAPI 规格并生成客户端。作为 Operator 作者,您可以使用 Kubebuilder 标记(注解)来配置 API 的自定义验证。这些标记必须始终具有

+kubebuilder:validation前缀。例如,可以通过添加以下标记来添加一个 enum-type 规格:// +kubebuilder:validation:Enum=Lion;Wolf;Dragon type Alias string

// +kubebuilder:validation:Enum=Lion;Wolf;Dragon type Alias stringCopy to Clipboard Copied! Toggle word wrap Toggle overflow API 代码中的标记用法会在 Kubebuilder 生成 CRD 和用于配置/代码生成的标记文档中讨论。Kubebuilder CRD 验证文档还提供了 OpenAPIv3 验证标记的完整列表。

如果您添加了任何自定义验证,请运行以下命令更新 CRD 的

deploy/crds/cache.example.com_memcacheds_crd.yaml文件中的 OpenAPI 验证部分:operator-sdk generate openapi

$ operator-sdk generate openapiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 生成的 YAML 示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 添加新控制器。

在项目中添加新控制器以观察和协调 Memcached 资源:

operator-sdk add controller \ --api-version=cache.example.com/v1alpha1 \ --kind=Memcached$ operator-sdk add controller \ --api-version=cache.example.com/v1alpha1 \ --kind=MemcachedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 这样会在

pkg/controller/memcached/下构建新控制器实现。在本示例中,将所生成的控制器文件

pkg/controller/memcached/memcached_controller.go替换成示例实现。示例控制器会对每个

MemcachedCR 执行以下协调逻辑:- 如果尚无 Memcached Deployment,请创建一个。

-

确保 Deployment 大小与

MemcachedCR spec 中指定的大小相同。 -

使用 Memcached Pod 的名称来更新

MemcachedCR 状态。

接下来的两个子步骤用于检查控制器如何监视资源以及协调循环会如何被触发。您可跳过这些步骤,直接构建和运行 Operator。

检查

pkg/controller/memcached/memcached_controller.go文件中的控制器实现,了解控制器如何监视资源。首先要监视的是作为主要资源的 Memcached 类型。对于每个添加、更新或删除事件,协调循环均会针对该 Memcached 对象发送一个协调

Request(<namespace>:<name>键):err := c.Watch( &source.Kind{Type: &cachev1alpha1.Memcached{}}, &handler.EnqueueRequestForObject{})err := c.Watch( &source.Kind{Type: &cachev1alpha1.Memcached{}}, &handler.EnqueueRequestForObject{})Copy to Clipboard Copied! Toggle word wrap Toggle overflow 接下来监视 Deployment,但事件处理程序会将每个事件映射到 Deployment 所有者的协调

Request中。即本例中为其创建 Deployment 的 Memcached 对象。这样可让控制器将 Deployment 视为辅助资源:err := c.Watch(&source.Kind{Type: &appsv1.Deployment{}}, &handler.EnqueueRequestForOwner{ IsController: true, OwnerType: &cachev1alpha1.Memcached{}, })err := c.Watch(&source.Kind{Type: &appsv1.Deployment{}}, &handler.EnqueueRequestForOwner{ IsController: true, OwnerType: &cachev1alpha1.Memcached{}, })Copy to Clipboard Copied! Toggle word wrap Toggle overflow 每个控制器均有一个协调器对象,且该对象带有实现协调循环的

Reconcile()方法。系统会将Request参数传递到该协调循环,该参数是一个用于从缓存中查找主资源对象 Memcached 的<namespace>:<name>键:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 根据

Reconcile()的返回值,协调Request可能会重新排队,且可能再次触发循环:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

构建并运行 Operator。

在运行 Operator 之前,必须使用 Kubernetes API 服务器来注册 CRD:

oc create \ -f deploy/crds/cache_v1alpha1_memcached_crd.yaml$ oc create \ -f deploy/crds/cache_v1alpha1_memcached_crd.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注册 CRD 之后,运行 Operator 时有两个选项可供选择:

- 作为 Kubernetes 集群内的一个 Deployment 来运行

- 作为集群外的 Go 程序运行

选择以下任一方法。

选项 A:作为集群内的一个 Deployment 来运行。

构建

memcached-operator镜像并将其推送至 registry:operator-sdk build quay.io/example/memcached-operator:v0.0.1

$ operator-sdk build quay.io/example/memcached-operator:v0.0.1Copy to Clipboard Copied! Toggle word wrap Toggle overflow Deployment 清单在

deploy/operator.yaml中生成。按如下方式更新 Deployment 镜像,因为默认值只是一个占位符:sed -i 's|REPLACE_IMAGE|quay.io/example/memcached-operator:v0.0.1|g' deploy/operator.yaml

$ sed -i 's|REPLACE_IMAGE|quay.io/example/memcached-operator:v0.0.1|g' deploy/operator.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

确保 Quay.io 上有一个可供下一步使用的账户,或者替换您的首选容器 registry。在 registry 中,创建一个名为

memcached-operator的新公共镜像存储库。 将镜像推送至 registry:

podman push quay.io/example/memcached-operator:v0.0.1

$ podman push quay.io/example/memcached-operator:v0.0.1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 设置 RBAC 并部署

memcached-operator:oc create -f deploy/role.yaml oc create -f deploy/role_binding.yaml oc create -f deploy/service_account.yaml oc create -f deploy/operator.yaml

$ oc create -f deploy/role.yaml $ oc create -f deploy/role_binding.yaml $ oc create -f deploy/service_account.yaml $ oc create -f deploy/operator.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证

memcached-operator是否正在运行:oc get deployment NAME DESIRED CURRENT UP-TO-DATE AVAILABLE AGE memcached-operator 1 1 1 1 1m

$ oc get deployment NAME DESIRED CURRENT UP-TO-DATE AVAILABLE AGE memcached-operator 1 1 1 1 1mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

选项 B:在集群外本地运行。

这是开发循环中的首选方法,可加快部署和测试的速度。

使用

$HOME/.kube/config中的默认 Kubernetes 配置文件在本地运行 Operator:operator-sdk up local --namespace=default

$ operator-sdk up local --namespace=defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 您可借助标记

--kubeconfig=<path/to/kubeconfig>来使用特定的kubeconfig。

通过创建 Memcached CR 来验证该 Operator 可否部署 Memcached 应用程序。

创建

deploy/crds/cache_v1alpha1_memcached_cr.yaml中生成的MemcachedCR 示例:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 确保

memcached-operator为 CR 创建 Deployment:oc get deployment NAME DESIRED CURRENT UP-TO-DATE AVAILABLE AGE memcached-operator 1 1 1 1 2m example-memcached 3 3 3 3 1m

$ oc get deployment NAME DESIRED CURRENT UP-TO-DATE AVAILABLE AGE memcached-operator 1 1 1 1 2m example-memcached 3 3 3 3 1mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查 Pod 和 CR 状态,以确认其状态中是否更新了

memcachedPod 名称:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

通过更新部署的大小来验证 Operator 可否管理所部署的 Memcached 应用程序。

将

memcachedCR 中的spec.size字段从3改为4:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 应用更改:

oc apply -f deploy/crds/cache_v1alpha1_memcached_cr.yaml

$ oc apply -f deploy/crds/cache_v1alpha1_memcached_cr.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 确认 Operator 已更改 Deployment 大小:

oc get deployment NAME DESIRED CURRENT UP-TO-DATE AVAILABLE AGE example-memcached 4 4 4 4 5m

$ oc get deployment NAME DESIRED CURRENT UP-TO-DATE AVAILABLE AGE example-memcached 4 4 4 4 5mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

清理资源:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

其他资源

- 如需有关 CRD 中的 OpenAPI v3.0 验证模式的更多信息,请参阅 Kubernetes 文档。

上一节介绍了如何手动运行 Operator。下面我们将探索如何使用 Operator Lifecycle Manager (OLM),OLM 将为生产环境中运行的 Operator 启用更强大的部署模型。

OLM 可帮助您在 Kubernetes 集群中安装、更新所有 Operator(及其相关服务)并对其整个生命周期实施一般性管理。OLM 将作为 Kubernetes 的扩展程序运行,支持您使用 oc 实现所有生命周期管理功能,而无需额外工具。

先决条件

-

基于 Kubernetes 的集群(v1.8 或更高版本,支持

apps/v1beta2API 组,如已启用预览 OLM 的 OpenShift Container Platform 4.3)上已安装 OLM - 已构建 Memcached Operator

流程

生成 Operator 清单。

Operator 清单描述了如何整体显示、创建和管理应用程序,即本例中的 Memcached。该清单由

ClusterServiceVersion(CSV) 对象定义,是运行 OLM 的必要条件。从您在构建 Memcached Operator 时创建的

memcached-operator/目录中生成 CSV 清单:operator-sdk olm-catalog gen-csv --csv-version 0.0.1

$ operator-sdk olm-catalog gen-csv --csv-version 0.0.1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意更多有关手动定义清单文件的信息,请参阅构建用于 Operator Framework 的 CSV。

创建一个 OperatorGroup,指定 Operator 的目标命名空间。在要创建 CSV 的命名空间中创建以下 OperatorGroup。本例中使用了

default命名空间:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 部署 Operator。使用在您构建 Memcached Operator 时由 Operator SDK 生成并存储至

deploy/目录中的文件。将 Operator 的 CSV 清单应用于集群中指定的命名空间:

oc apply -f deploy/olm-catalog/memcached-operator/0.0.1/memcached-operator.v0.0.1.clusterserviceversion.yaml

$ oc apply -f deploy/olm-catalog/memcached-operator/0.0.1/memcached-operator.v0.0.1.clusterserviceversion.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 应用该清单时,集群不会立即更新,因为尚未满足清单中指定的要求。

创建角色、角色绑定和服务账户以便向 Operator 授予资源权限,创建自定义资源定义 (CRD) 以便创建受 Operator 管理的 Memcached 类型:

oc create -f deploy/crds/cache.example.com_memcacheds_crd.yaml oc create -f deploy/service_account.yaml oc create -f deploy/role.yaml oc create -f deploy/role_binding.yaml

$ oc create -f deploy/crds/cache.example.com_memcacheds_crd.yaml $ oc create -f deploy/service_account.yaml $ oc create -f deploy/role.yaml $ oc create -f deploy/role_binding.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 因为在应用清单时,OLM 会在特定命名空间中创建 Operator,所以管理员可利用原生 Kubernetes RBAC 权限模型来限制哪些用户可以安装 Operator。

创建应用程序实例。

Memcached Operator 正在

default命名空间中运行。用户通过CustomResource实例与 Operator 交互;这种情况下,资源拥有类型Memcached。原生 Kubernetes RBAC 也适用于CustomResource,让管理员能够控制与每个 Operator 的交互。在该命名空间中创建 Memcached 实例将触发 Memcached Operator,以针对运行由 Operator 管理的 Memcached 服务器的 Pod 进行实例化。您创建的

CustomResource越多,在此命名空间中运行的 Memcached Operator 管理的 Memcached 实例就越独特。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 更新应用程序。

通过引用旧 Operator 清单的

replaces字段来创建新 Operator 清单,以手动更新 Operator。OLM 可确保由旧 Operator 管理的所有资源的所有权均转移到至新 Operator,而不用担心任何程序停止执行。升级资源以便在新版 Operator 下运行所需的所有数据迁移均将由 Operator 直接执行。以下命令演示了如何使用新版 Operator 来应用新的 Operator 清单文件,并显示了 Pod 仍在执行:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

12.1.5. 其他资源

- 有关 Operator SDK 所创建的项目目录结构的信息,请参阅附录。

- 面向红帽合作伙伴的 Operator 开发指南

12.2. 创建基于 Ansible 的 Operator

本指南概述了 Operator SDK 中的 Ansible 支持,通过一些示例指导 Operator 作者通过使用 Ansible playbook 和模块的 operator-sdk CLI 工具来构建和运行基于 Ansible 的 Operator。

12.2.1. Operator SDK 中的 Ansible 支持

Operator Framework 是一个开源工具包,用于以有效、自动化且可扩展的方式管理 Kubernetes 原生应用程序,即 Operator。该框架中包含 Operator SDK,可协助开发人员利用自己的专业知识来引导和构建 Operator,而无需了解 Kubernetes API 复杂性。

通过 Operator SDK 生成 Operator 项目的其中一种方案是利用现有 Ansible playbook 和模块来部署 Kubernetes 资源作为统一应用程序,而无需编写任何 Go 代码。

12.2.1.1. 自定义资源文件

Operator 会使用 Kubernetes 的扩展机制,即自定义资源定义 (CRD),这样您的自定义资源 (CR) 的外观和行为均类似于内置的原生 Kubernetes 对象。

CR 文件格式是一个 Kubernetes 资源文件。该对象具有必填和选填字段:

| 字段 | 描述 |

|---|---|

|

| 要创建 CR 的版本。 |

|

| 要创建 CR 的类型。 |

|

| 要创建的 Kubernetes 特定元数据。 |

|

| 传输至 Ansible 的变量键值列表。本字段默认为空。 |

|

|

总结对象的当前状态。对于基于 Ansible 的 Operator, |

|

| 要附于 CR 的 Kubernetes 特定注解。 |

以下 CR 注解列表会修改 Operator 的行为:

| 注解 | 描述 |

|---|---|

|

|

为 CR 指定协调间隔。该值将通过标准 Golang 软件包 |

基于 Ansible 的 Operator 注解示例

12.2.1.2. Watches 文件

Watches 文件中包含从自定义资源 (CR)(通过 Group、Version 和 Kind 标识)到 Ansible 角色或 playbook 的映射列表。Operator 期望该映射文件位于预定义位置,/opt/ansible/watches.yaml。

| 字段 | 描述 |

|---|---|

|

| 要监视的 CR 组。 |

|

| 要监视的 CR 版本。 |

|

| 要监视的 CR 类型 |

|

|

添加至容器中的 Ansible 角色的路径。例如:如果您的 |

|

|

添加至容器中的 Ansible playbook 的路径。该 playbook 需要以简单方式调用角色。该字段与 |

|

| 给定 CR 的协调间隔,角色或 playbook 运行的频率。 |

|

|

如果设置为 |

Watches 文件示例

12.2.1.2.1. 高级选项

高级功能可通过添加至每个 GVK(group、version 和 kind)的 Watches 文件中进行启用。它们可放在 group、version、kind 和 playbook 或 role 字段下方。

可使用自定义资源 (CR) 上的注解覆盖每个资源的某些功能。可覆盖的选项会指定以下注解。

| 功能 | YAML 密钥 | 描述 | 覆盖注解 | 默认值 |

|---|---|---|---|---|

| 协调周期 |

| 特定 CR 的协调运行间隔时间。 |

|

|

| 管理状态 |

|

支持 Operator 管理每个 CR |

| |

| 监视依赖资源 |

| 支持 Operator 动态监视由 Ansible 创建的资源。 |

| |

| 监控集群范围内的资源 |

| 支持 Operator 监视由 Ansible 创建的集群范围的资源。 |

| |

| 最大运行程序工件 |

| 管理 Ansible Runner 在 Operator 容器中为每个单独资源保存的构件目录的数量。 |

|

|

带有高级选项的 Watches 文件示例

12.2.1.3. 发送至 Ansible 的额外变量

额外变量可发送至 Ansible,然后由 Operator 管理。自定义资源 (CR) 的 spec 部分作为额外变量按照键值对传递。等同于传递给 ansible-playbook 命令的额外变量。

Operator 还会在 meta 字段下传递额外变量,用于 CR 的名称和 CR 的命名空间。

对于以下 CR 示例:

作为额外变量传递至 Ansible 的结构为:

message 和 newParameter 字段在顶层被设置为额外变量,meta 则为 Operator 中定义的 CR 提供相关元数据。meta 字段可使用 Ansible 中的点符号来访问,如:

- debug:

msg: "name: {{ meta.name }}, {{ meta.namespace }}"

- debug:

msg: "name: {{ meta.name }}, {{ meta.namespace }}"12.2.1.4. Ansible Runner 目录

Ansible Runner 会将与 Ansible 运行相关的信息保存至容器中。具体位于:/tmp/ansible-operator/runner/<group>/<version>/<kind>/<namespace>/<name>。

其他资源

-

要了解有关

runner目录的更多信息,请参阅 Ansible Runner 文档。

12.2.2. 安装 Operator SDK CLI

Operator SDK 配有一个 CLI 工具,可协助开发人员创建、构建和部署新的 Operator 项目。您可在工作站上安装 SDK CLI,为编写您自己的 Operator 做准备。

12.2.2.1. 从 GitHub 版本安装