Debezium 用户指南

前言

Debezium 是一组分布式服务,用于捕获数据库中的行级更改,以便您的应用程序可以查看并响应这些更改。Debezium 记录提交到每个数据库表的所有行级别更改。每个应用程序都会读取感兴趣的事务日志,以便按照它们发生的顺序查看所有操作。

本指南详细介绍了使用以下 Debezium 主题:

- 第 1 章 Debezium 的高级别概述

- 第 2 章 所需的自定义资源升级

- 第 3 章 Db2 的 Debezium 连接器

- 第 4 章 MongoDB 的 Debezium 连接器

- 第 5 章 MySQL 的 Debezium 连接器

- 第 6 章 Oracle 的 Debezium Connector

- 第 7 章 PostgreSQL 的 Debezium 连接器

- 第 8 章 SQL Server 的 Debezium 连接器

- 第 9 章 监控 Debezium

- 第 10 章 Debezium 日志记录

- 第 11 章 为应用程序配置 Debezium 连接器

- 第 12 章 应用转换以修改使用 Apache Kafka 交换的消息

- 第 13 章 开发 Debezium 自定义数据类型转换器

使开源包含更多

红帽致力于替换我们的代码、文档和 Web 属性中存在问题的语言。我们从这四个术语开始:master、slave、黑名单和白名单。由于此项工作十分艰巨,这些更改将在即将推出的几个发行版本中逐步实施。有关更多详情,请参阅我们的首席技术官 Chris Wright 提供的消息。

第 1 章 Debezium 的高级别概述

Debezium 是一组分布式服务,用于捕获数据库中的更改。您的应用程序可以消耗并响应这些更改。Debezium 在更改事件记录中捕获每个数据库表中的每行级别更改,并将这些记录流传输到 Kafka 主题。应用程序读取这些流,其按生成顺序提供更改事件记录。

在以下部分中提供了更多详细信息:

1.1. Debezium 功能

Debezium 是 Apache Kafka Connect 的一组源连接器。每个连接器都使用该数据库的功能更改数据捕获(CDC),从不同数据库更改更改。与其他方法不同,如轮询或双写,基于日志的 CDC (如 Debezium 实施):

- 确保 捕获所有数据更改。

- 生成具有 非常低延迟的 更改事件,同时避免增加频繁轮询所需的 CPU 用量。例如,对于 MySQL 或 PostgreSQL,延迟位于毫秒范围内。

- 不需要更改数据模型,如"Last Updated"列。

- 可以捕获 删除。

- 可以捕获旧的记录状态和其他元数据,如事务 ID,并导致查询,具体取决于数据库的功能和配置。

基于 Log-Based Change Data Capture 的五个 Advantages 是一个博客文章,它提供更多详细信息。

Debezium 连接器使用各种相关功能和选项捕获数据更改:

- 快照: 如果连接器启动且并非所有日志仍然存在,则可以生成数据库当前状态的初始快照。通常,当数据库一段时间运行时,这是这种情况,并丢弃了事务恢复或复制不再需要的事务日志。执行快照的方式有不同的模式,包括对 增量 快照的支持,这些快照可以在连接器运行时触发。如需了解更多详细信息,请参阅您使用的连接器文档。

- 过滤器: 您可以使用 include/exclude 列表过滤器配置捕获的模式、表和列的集合。

- 屏蔽: 特定列中的值可以屏蔽,例如当它们包含敏感数据时。

- 监控 : 大多数连接器可以使用 JMX 监控。

- 随时使用的单个消息 转换(SMT) 用于消息路由、过滤、事件扁平化等。有关 Debezium 提供的 SMT 的更多信息,请参阅 应用转换来修改与 Apache Kafka 交换的消息。

每个连接器的文档提供了有关连接器功能和配置选项的详细信息。

1.2. Debezium 架构描述

您可以使用 Apache Kafka Connect 部署 Debezium。Kafka Connect 是一个用于实施和操作的框架和运行时:

- 源连接器,如将记录发送到 Kafka 的 Debezium

- 将记录从 Kafka 主题传播到其他系统的接收器连接器

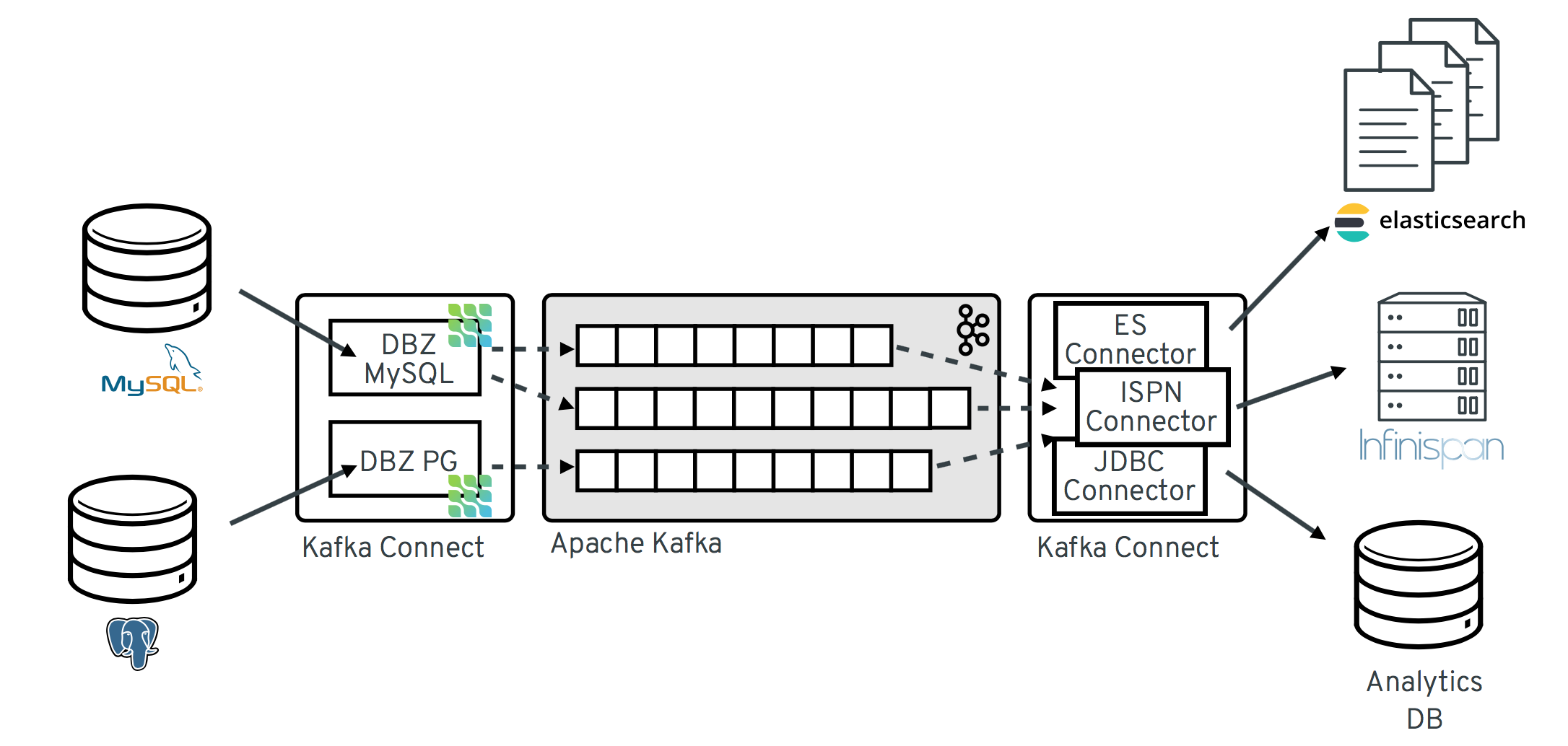

下图显示了基于 Debezium 的更改数据捕获管道的架构:

如镜像所示,为 MySQL 和 PostgresSQL 部署 Debezium 连接器,以捕获对这两种类型的数据库的更改。每个 Debezium 连接器建立与源数据库的连接:

-

MySQL 连接器使用客户端库来访问

binlog。 - PostgreSQL 连接器从逻辑复制流读取。

除了 Kafka 代理外,Kafka Connect 作为单独的服务运行。

默认情况下,从一个数据库表中的更改被写入 Kafka 主题,其名称与表名称对应。如果需要,您可以通过配置 Debezium 的主题 路由转换来调整目标主题名称。例如,您可以:

- 将记录路由到名称与表名称不同的主题

- 在一个主题中,多个表的流更改事件记录

在 Apache Kafka 中更改了事件记录后,Kafka Connect eco-system 中的不同连接器可以将记录流传输到其他系统和数据库,如 Elasticsearch、数据科学家和分析系统或 Infinispan 等缓存。根据所选的接收器连接器,您可能需要配置 Debezium 的新记录状态提取 转换。此 Kafka Connect SMT 将 after 结构从 Debezium 的更改事件传播到接收器连接器。这是默认传播的详细更改事件记录。

第 2 章 所需的自定义资源升级

Debezium 是一个 Kafka 连接器插件,它部署到在 OpenShift 上的 AMQ Streams 上运行的 Apache Kafka 集群。要准备 OpenShift CRD v1,在 AMQ Streams 的当前版本中,自定义资源定义(CRD) API 所需的版本现在设置为 v1beta2。API 的 v1beta2 版本替换了之前支持的 v1beta1 和 v1alpha1 API 版本。对 v1alpha1 和 v1beta1 API 版本的支持现在在 AMQ Streams 中已弃用。这些早期版本现已从大多数 AMQ Streams 自定义资源中删除,包括用来配置 Debezium 连接器的 KafkaConnect 和 KafkaConnector 资源。

基于 v1beta2 API 版本的 CRD 使用 OpenAPI structural 模式。基于被取代的 v1alpha1 或 v1beta1 API 的自定义资源不支持结构模式,并与 AMQ Streams 的当前版本不兼容。在升级到 AMQ Streams2.3 之前,您必须升级现有的自定义资源以使用 API 版本 kafka.strimzi.io/v1beta2。在升级到 AMQ Streams 1.7 后,您可以随时升级自定义资源。在升级到 AMQ Streams2.3 或更新版本前,您必须完成 v1beta2 API 的升级。

为了便于对 CRD 和自定义资源进行升级,AMQ Streams 提供了一个 API 转换工具,可自动将它们升级到与 v1beta2 兼容的格式。有关该工具以及如何升级 AMQ Streams 的完整说明,请参阅在 OpenShift 中部署和升级 AMQ Streams。

更新自定义资源的要求只适用于在 OpenShift 上的 AMQ Streams 上运行的 Debezium 部署。要求不适用于 Red Hat Enterprise Linux 上的 Debezium

第 3 章 Db2 的 Debezium 连接器

Debezium 的 Db2 连接器可以捕获 Db2 数据库表中的行级更改。有关与此连接器兼容的 Db2 数据库版本的详情,请参考 Debezium 支持的配置页面。

这个连接器主要由 SQL Server 的 Debezium 实施而利用,它使用基于 SQL 的轮询模型将表置于"捕获模式"。当表处于捕获模式时,Debebe Db2 连接器会为该表的每一行级更新生成并流传输更改事件。

处于捕获模式的表具有一个关联的 change-data 表,Db2 创建它。对于处于捕获模式的表的每个更改,Db2 都会向表的相关 change-data 表添加有关该更改的数据。change-data 表包含一行状态的条目。它还具有用于删除的特殊条目。Debezium Db2 连接器从 change-data 表中读取更改事件,并将事件发送到 Kafka 主题。

当 Debezium Db2 连接器连接到 Db2 数据库时,连接器会读取连接器配置为捕获更改的表的一致性快照。默认情况下,这是所有非系统表。有连接器配置属性,允许您指定要放入捕获模式的表,或者从捕获模式中排除哪些表。

快照完成后,连接器开始向处于捕获模式的表发出提交更新的更改事件。默认情况下,更改特定表的事件进入一个 Kafka 主题,其名称与表相同。应用程序和服务消耗从这些主题更改事件。

连接器需要使用抽象语法表示法(ASN)库,该库作为 Linux 的 Db2 的标准部分提供。要使用 ASN 库,您必须有 IBM InfoSphere Data Replication (IIDR)的许可证。您不必安装 IIDR 来使用 ASN 库。

使用 Debezium Db2 连接器的信息和流程进行组织如下:

3.1. Debezium Db2 连接器概述

Debezium Db2 连接器基于 ASN Capture/Apply 代理,用于在 Db2 中启用 SQL 复制。捕获代理:

- 为处于捕获模式的表生成 change-data 表。

- 以捕获模式监控表,并将更改事件存储在对应的 change-data 表中。

Debezium 连接器使用 SQL 接口来查询 change-data 表以更改事件。

数据库管理员必须将要捕获更改的表置于捕获模式。为方便起见,在 C 中有 Debezium 管理用户定义的功能(UDF),您可以编译,然后使用 进行以下管理任务:

- 启动、停止和重新初始化 ASN 代理

- 将表置于捕获模式

- 创建复制(ASN)模式和 change-data 表

- 从捕获模式中删除表

或者,您可以使用 Db2 控制命令来完成这些任务。

在感兴趣的表处于捕获模式后,连接器会读取对应的 change-data 表,以获取表更新的更改事件。连接器会为每行级别的插入、更新和删除操作发出一个更改事件到与更改表相同的 Kafka 主题。这是您可以修改的默认行为。客户端应用程序读取与感兴趣的数据库表对应的 Kafka 主题,并可响应每行级别的更改事件。

通常,数据库管理员在表生命周期中将表置于捕获模式。这意味着连接器没有对表所做的任何更改的完整历史记录。因此,当 Db2 连接器第一次连接到特定的 Db2 数据库时,它首先对处于捕获模式的每个表执行 一致的快照。连接器完成快照后,连接器流会从进行快照的点更改事件。这样,连接器从处于捕获模式的表的统一视图开始,且不会丢弃执行快照时所做的任何更改。

Debezium 连接器可以容错失败。当连接器读取并生成更改事件时,它会记录 change-data 表条目的日志序列号(LSN)。LSN 是更改事件在数据库日志中的位置。如果连接器因任何原因而停止,包括通信失败、网络问题或崩溃,则继续读取它离开的 change-data 表。这包括快照。也就是说,如果连接器在重启连接器开始新快照时没有完成快照。

3.2. Debezium Db2 连接器如何工作

为了最佳配置和运行 Debezium Db2 连接器,了解连接器如何执行快照、流更改事件、决定 Kafka 主题名称以及处理架构更改会很有帮助。

详情包括在以下主题中:

3.2.1. Debezium Db2 连接器如何执行数据库快照

Db2 的复制功能不是存储数据库更改的完整历史记录。因此,当 Debezium Db2 连接器第一次连接到数据库时,它会生成处于捕获模式的表快照,并将这个状态流传输到 Kafka。这会为表内容建立基准。

默认情况下,当 Db2 连接器执行快照时,它会执行以下操作:

-

确定哪些表处于捕获模式,因此必须包含在快照中。默认情况下,所有非系统表都处于捕获模式。连接器配置属性,如

table.exclude.list和table.include.list,允许您指定哪些表应处于捕获模式。 -

以捕获模式获取每个表的锁定。这样可确保在快照期间不会在这些表中发生架构更改。锁定的级别由

snapshot.isolation.mode连接器配置属性决定。 - 在服务器的事务日志中读取最高(最新)LSN 位置。

- 捕获处于捕获模式的所有表的模式。连接器在其内部数据库模式历史记录主题中保留此信息。

- 可选,释放在第 2 步中获取的锁定。通常,这些锁定只会在短时间内保留。

在第 3 步中读取的 LSN 位置中,连接器会扫描捕获模式表及其模式。在扫描过程中,连接器:

- 确认在快照开始前创建了表。如果没有,则快照将跳过该表。快照完成后,连接器开始发出更改事件,连接器会为快照期间创建的任何表生成更改事件。

- 为处于捕获模式的每个行生成 读取 事件。所有 读取 事件都包含相同的 LSN 位置,这是在第 3 步中获取的 LSN 位置。

- 将每个 读取 事件发送到与表同名的 Kafka 主题。

- 在连接器偏移中记录成功完成快照。

3.2.1.1. 临时快照

默认情况下,连接器仅在首次启动后运行初始快照操作。在正常情况下,遵循这个初始快照,连接器不会重复快照过程。连接器捕获的任何将来更改事件数据都仅通过流传输过程。

然而,在某些情况下,连接器在初始快照期间获取的数据可能会变得过时、丢失或不完整。为了提供总结表数据的机制,Debezium 包含一个执行临时快照的选项。数据库中的以下更改可能是执行临时快照:

- 连接器配置会被修改为捕获不同的表集合。

- Kafka 主题已删除,必须重建。

- 由于配置错误或某些其他问题导致数据损坏。

您可以通过启动所谓的 临时命令快照,为之前捕获的快照重新运行快照。临时快照需要使用 信号表。您可以通过向 Debezium 信号表发送信号请求来启动临时快照。

当您启动现有表的临时快照时,连接器会将内容附加到表已存在的主题中。如果删除了之前存在的主题,如果启用自动主题创建,Debezium 可以自动创建主题。https://access.redhat.com/documentation/zh-cn/red_hat_build_of_debezium/2.1.4/html-single/debezium_user_guide/index#customization-of-kafka-connect-automatic-topic-creation

临时快照信号指定要包含在快照中的表。快照可以捕获数据库的整个内容,或者只捕获数据库中表的子集。另外,快照也可以捕获数据库中表内容的子集。

您可以通过向信号表发送 execute-snapshot 消息来指定要捕获的表。将 execute-snapshot 信号的类型设置为增量,并提供快照中包含的表名称,如下表所述:

| 字段 | 默认 | 值 |

|---|---|---|

|

|

|

指定您要运行的快照类型。 |

|

| 不适用 |

包含与要快照的表的完全限定域名匹配的正则表达式的数组。 |

|

| 不适用 | 可选字符串,它根据表的列指定条件,用于捕获表内容的子集。 |

触发临时快照

您可以通过在信号表中添加带有 execute-snapshot 信号类型的条目来启动临时快照。连接器处理消息后,它会开始快照操作。快照过程读取第一个和最后一个主密钥值,并使用这些值作为每个表的开头和端点。根据表中的条目数量以及配置的块大小,Debezium 将表分成块,并一次为每个块进行快照。

3.2.1.2. 增量快照

为了提供管理快照的灵活性,Debezium 包括一个补充的快照机制,称为 增量快照。增量快照依赖于 Debezium 机制 向 Debezium 连接器发送信号。

在增量快照中,而不是一次性捕获数据库的完整状态,如初始快照,Debezium 以一系列可配置的块的形式捕获每个表。您可以指定您希望快照捕获的表,以及每个块的大小。块大小决定了快照在数据库的每个获取操作期间收集的行数。增量快照的默认块大小为 1 KB。

当增量快照进行时,Debezium 使用水位线来跟踪其进度,维护它捕获的每一个表行的记录。这个阶段捕获数据的方法比标准初始快照过程提供以下优点:

- 您可以使用流化数据捕获并行运行增量快照,而不是经过发布流,直到快照完成为止。连接器会继续在整个快照过程中从更改日志捕获接近实时事件,且操作都不会阻断其他事件。

- 如果增量快照的进度中断,您可以在不丢失任何数据的情况下恢复它。在进程恢复后,快照从停止的时间开始,而不是从开始重新定义表。

-

您可以随时根据需要运行增量快照,并根据需要重复这个过程以适应数据库更新。例如,您可以在修改连接器配置后重新运行快照,以将表添加到其

table.include.list属性中。

增量快照过程

当您运行增量快照时,Debezium 按主密钥对表进行排序,然后根据 配置的块大小 将表分成块。然后,按块使用块,然后在块中捕获每个表行。对于它捕获的每行,快照会发出 READ 事件。该事件代表了块开始快照时的行值。

当快照继续进行时,其他进程可能会继续访问数据库,从而可能会修改表记录。要反映此类更改,INSERT、UPDATE 或 DELETE 操作会照常提交到事务日志中。同样,持续 Debezium 流过程还会继续检测这些更改事件,并将对应的更改事件记录发送到 Kafka。

Debezium 如何使用相同的主密钥解决记录间的冲突

在某些情况下,流传输进程发出的 UPDATE 或 DELETE 事件会耗尽序列。也就是说,流过程可能会发出一个事件,它会在快照捕获包含该行的 READ 事件之前修改表行。当快照最终会为行发出对应的 READ 事件时,其值已经被替换。为确保以正确的逻辑顺序处理到达序列的增量快照事件,Debezium 会使用一种缓冲区方案来解决冲突。只有在快照事件和流事件间冲突时才解决后,Debezium 会向 Kafka 发送事件记录。

快照窗口

为了帮助解决后续 READ 事件和修改同一表行的流事件之间的冲突,Debezium 采用所谓的 快照窗口。快照窗口分离了增量快照捕获指定表块的数据的时间间隔。在打开块的快照窗口前,Debebe 会遵循其常见的行为,并将事件直接从事务日志直接降级到目标 Kafka 主题。但是,从打开特定块的快照时,Debebe 会执行重复数据删除步骤,以解决具有相同主密钥的事件之间冲突。

对于每个数据收集,Debezium 会发出两种类型的事件,并将其记录存储在单个目标 Kafka 主题中。它直接从表中捕获的快照记录作为 READ 操作发出。同时,当用户继续更新数据收集中的记录,并更新事务日志以反映每个提交,Debezium 会为每个更改发出 UPDATE 或 DELETE 操作。

当快照窗口打开时,Debezium 开始处理快照块,它会将快照记录提供给内存缓冲区。在快照窗口中,缓冲区中 READ 事件的主键将与传入流事件的主键进行比较。如果没有找到匹配项,流的事件记录将直接发送到 Kafka。如果 Debezium 检测到匹配项,它会丢弃缓冲的 READ 事件,并将流的记录写入目标主题,因为流的事件逻辑地替换静态快照事件。在块的快照窗口关闭后,缓冲区仅包含没有相关事务日志事件的 READ 事件。Debezium 将这些剩余的 READ 事件发送到表的 Kafka 主题。

连接器重复每个快照块的进程。

Db2 的 Debezium 连接器不支持增量快照运行时的 schema 更改。

3.2.1.3. 触发增量快照

目前,启动增量快照的唯一方法是向源数据库上的 信号发送临时快照 信号。

您可以以 SQL INSERT 查询形式向信号表提交信号。

在 Debezium 检测到信号表中的更改后,它会读取信号,并运行请求的快照操作。

您提交的查询指定要包含在快照中的表,以及可选的指定快照操作类型。目前,快照操作的唯一有效选项是默认值 增量。

要指定快照中包含的表,请提供一个 data-collections 数组,该数组列出了用于匹配表的表或一组正则表达式,例如:

{"data-collections": ["public.MyFirstTable", "public.MySecondTable"]}

增量快照信号的 data-collections 数组没有默认值。如果 data-collections 数组为空,Debezium 会检测到不需要任何操作,且不执行快照。

如果要包含在快照中的表名称包含数据库、模式或表名称的句点(.),要将表添加到 data-collections 数组中,您必须用双引号转义名称的每个部分。

例如,若要包含 公共 模式中存在的表,并且名为 My.Table,请使用以下格式:" public"."My.Table "。

先决条件

- 源数据库中存在信号数据收集。

-

信号数据收集在

signal.data.collection属性中指定。

流程

发送 SQL 查询,将临时增量快照请求添加到信号表中:

INSERT INTO <signalTable> (id, type, data) VALUES ('<id>', '<snapshotType>', '{"data-collections": ["<tableName>","<tableName>"],"type":"<snapshotType>","additional-condition":"<additional-condition>"}');INSERT INTO <signalTable> (id, type, data) VALUES ('<id>', '<snapshotType>', '{"data-collections": ["<tableName>","<tableName>"],"type":"<snapshotType>","additional-condition":"<additional-condition>"}');Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如,

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 命令中的

id、type和data参数的值对应于 信号表的字段。下表描述了示例中的参数:

Expand 表 3.2. 向信号表发送增量快照信号的 SQL 命令中的字段描述 项 值 描述 1

myschema.debezium_signal指定源数据库上信号表的完全限定名称。

2

ad-hoc-1id参数指定分配给信号请求的id标识符的任意字符串。

使用此字符串来标识到信号表中条目的日志消息。Debezium 不使用此字符串。相反,在快照中,Debebe 会生成自己的id字符串作为水位信号。3

execute-snapshottype参数指定信号要触发的操作。

4

data-collections信号的

data字段所需的组件,用于指定表名称或正则表达式数组,以匹配快照中包含的表名称。

数组列出了根据完全限定名称匹配表的正则表达式,其格式与您用来指定signal.data.collection配置属性中的连接器信号表的名称相同。5

增量信号的

data字段的可选类型组件,用于指定要运行的快照操作类型。

目前,唯一有效选项是默认值增量。

如果没有指定值,连接器将运行一个增量快照。6

additional-condition可选字符串,它根据表的列指定条件,用于捕获表内容的子集。有关

additional-condition参数的详情请参考带有额外条件的临时增量快照。

带有额外条件的临时增量快照

如果您希望快照在表中仅包含内容子集,您可以通过将 additional-condition 参数附加到快照信号来修改信号请求。

典型的快照的 SQL 查询采用以下格式:

SELECT * FROM <tableName> ....

SELECT * FROM <tableName> ....

通过添加 additional-condition 参数,您可以将 WHERE 条件附加到 SQL 查询中,如下例所示:

SELECT * FROM <tableName> WHERE <additional-condition> ....

SELECT * FROM <tableName> WHERE <additional-condition> ....以下示例显示了向信号表发送带有额外条件的临时增量快照请求的 SQL 查询:

INSERT INTO <signalTable> (id, type, data) VALUES ('<id>', '<snapshotType>', '{"data-collections": ["<tableName>","<tableName>"],"type":"<snapshotType>","additional-condition":"<additional-condition>"}');

INSERT INTO <signalTable> (id, type, data) VALUES ('<id>', '<snapshotType>', '{"data-collections": ["<tableName>","<tableName>"],"type":"<snapshotType>","additional-condition":"<additional-condition>"}');

例如,假设您有一个包含以下列的产品表:

-

id(主密钥) -

color -

quantity

如果您希望 product 表的增量快照只包含 color=blue 的数据项,您可以使用以下 SQL 语句来触发快照:

INSERT INTO myschema.debezium_signal (id, type, data) VALUES('ad-hoc-1', 'execute-snapshot', '{"data-collections": ["schema1.products"],"type":"incremental", "additional-condition":"color=blue"}');

INSERT INTO myschema.debezium_signal (id, type, data) VALUES('ad-hoc-1', 'execute-snapshot', '{"data-collections": ["schema1.products"],"type":"incremental", "additional-condition":"color=blue"}');

additional-condition 参数还允许您传递基于多个列的条件。例如,使用上例中的 product 表,您可以提交查询来触发增量快照,该快照仅包含那些项目的 data =blue 和 quantity>10 :

INSERT INTO myschema.debezium_signal (id, type, data) VALUES('ad-hoc-1', 'execute-snapshot', '{"data-collections": ["schema1.products"],"type":"incremental", "additional-condition":"color=blue AND quantity>10"}');

INSERT INTO myschema.debezium_signal (id, type, data) VALUES('ad-hoc-1', 'execute-snapshot', '{"data-collections": ["schema1.products"],"type":"incremental", "additional-condition":"color=blue AND quantity>10"}');以下示例显示了连接器捕获的增量快照事件的 JSON。

示例:增加快照事件信息

| 项 | 字段名称 | 描述 |

|---|---|---|

| 1 |

|

指定要运行的快照操作类型。 |

| 2 |

|

指定事件类型。 |

3.2.1.4. 停止增量快照

您还可以通过向源数据库上的表发送信号来停止增量快照。您可以通过发送 SQL INSERT 查询,向表提交停止快照信号。

在 Debezium 检测到信号表中的更改后,它会读取信号,并在进行时停止增量快照操作。

您提交的查询指定了 增量 的快照操作,以及可选的、要删除的当前运行快照的表。

先决条件

- 源数据库中存在信号数据收集。

-

信号数据收集在

signal.data.collection属性中指定。

流程

发送 SQL 查询以停止临时增量快照到信号表:

INSERT INTO <signalTable> (id, type, data) values ('<id>', 'stop-snapshot', '{"data-collections": ["<tableName>","<tableName>"],"type":"incremental"}');INSERT INTO <signalTable> (id, type, data) values ('<id>', 'stop-snapshot', '{"data-collections": ["<tableName>","<tableName>"],"type":"incremental"}');Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如,

INSERT INTO myschema.debezium_signal (id, type, data) values ('ad-hoc-1', 'stop-snapshot', '{"data-collections": ["schema1.table1", "schema2.table2"], "type":"incremental"}');INSERT INTO myschema.debezium_signal (id, type, data)1 values ('ad-hoc-1',2 'stop-snapshot',3 '{"data-collections": ["schema1.table1", "schema2.table2"],4 "type":"incremental"}');5 Copy to Clipboard Copied! Toggle word wrap Toggle overflow signal 命令中的

id、type和data参数的值对应于 信号表的字段。下表描述了示例中的参数:

Expand 表 3.3. 向信号表发送停止增量快照信号的 SQL 命令中的字段描述 项 值 描述 1

myschema.debezium_signal指定源数据库上信号表的完全限定名称。

2

ad-hoc-1id参数指定分配给信号请求的id标识符的任意字符串。

使用此字符串来标识到信号表中条目的日志消息。Debezium 不使用此字符串。3

stop-snapshot指定

type参数指定信号要触发的操作。

4

data-collections信号的

data字段的可选组件,用于指定表名称或正则表达式数组,以匹配要从快照中删除的表名称。

数组列出了根据完全限定名称匹配表的正则表达式,其格式与您用来指定signal.data.collection配置属性中的连接器信号表的名称相同。如果省略了data字段的此组件,则信号将停止正在进行的整个增量快照。5

增量信号的

data字段所需的组件,用于指定要停止的快照操作类型。

目前,唯一有效选项是增量的。

如果没有指定类型值,则信号无法停止增量快照。

3.2.2. Debezium Db2 连接器如何读取更改数据表

完成快照后,当 Debezium Db2 连接器首次启动后,连接器会标识处于捕获模式的每个源表的 change-data 表。连接器为每个 change-data 表执行以下操作:

- 读取上次存储、最高 LSN 和当前最高 LSN 之间创建的更改事件。

- 根据提交 LSN 和每个事件的更改 LSN 排序更改事件。这样可确保连接器按表更改的顺序发出更改事件。

- 将提交并更改 LSNs 作为偏移到 Kafka Connect。

- 存储连接器传递给 Kafka Connect 的最高 LSN。

重启后,连接器会从关闭的偏移(提交并更改 LSN)中恢复发出更改事件。当连接器正在运行并发出更改事件时,如果您从捕获模式中删除表,或者添加表来捕获模式,连接器会检测到更改并相应地修改其行为。

3.2.3. 接收 Debezium Db2 更改事件记录的 Kafka 主题默认名称

默认情况下,Db2 连接器将表中发生的所有 INSERT、UPDATE 和 DELETE 操作的更改事件写入特定于该表的单个 Apache Kafka 主题。连接器使用以下惯例命名更改事件主题:

topicPrefix.schemaName.tableName

以下列表提供默认名称组件的定义:

- topicPrefix

-

由

topic.prefix连接器配置属性指定的主题前缀。 - schemaName

- 在其中操作的 schema 的名称。

- tableName

- 操作发生的表的名称。

例如,一个使用 mydatabase 数据库的 Db2 安装,其中包含四个表:PRODUCTS, PRODUCTS_ON_HAND, CUSTOMERS, 和 ORDERS,它们包括在 MYSCHEMA schema 中。连接器会将事件发送到这四个 Kafka 主题:

-

mydatabase.MYSCHEMA.PRODUCTS -

mydatabase.MYSCHEMA.PRODUCTS_ON_HAND -

mydatabase.MYSCHEMA.CUSTOMERS -

mydatabase.MYSCHEMA.ORDERS

连接器应用类似的命名约定来标记其内部数据库架构历史记录主题、架构更改主题 以及 事务元数据主题。

如果默认主题名称不满足您的要求,您可以配置自定义主题名称。要配置自定义主题名称,您可以在逻辑主题路由 SMT 中指定正则表达式。有关使用逻辑主题路由 SMT 自定义主题命名的更多信息,请参阅 主题路由。

3.2.4. 关于 Debezium Db2 连接器模式更改主题

您可以配置 Debezium Db2 连接器来生成 schema 更改事件,该事件描述了应用于数据库中捕获的表的 schema 更改。

Debezium 在以下情况下向 schema 更改主题发送信息:

- 新表进入捕获模式。

- 表已从捕获模式中删除。

- 在 数据库 schema 更新过程中,表在捕获模式下有变化。

连接器将模式更改事件改为 Kafka 模式更改主题,其名称为 < topicPrefix& gt;,其中 < ;topicPrefix > 是 topic.prefix connector 配置属性中指定的主题前缀。连接器发送到 schema 更改主题的消息包含以下元素的有效负载:

databaseName-

将语句应用到的数据库的名称。

databaseName的值充当 message 键。 pos- 出现语句的 binlog 中的位置。

tableChanges-

模式更改后整个表架构的结构化表示。

tableChanges字段包含一个数组,其中包含表中的每个列的条目。由于结构化表示以 JSON 或 Avro 格式呈现数据,因此用户可以轻松地读取消息,而无需首先通过 DDL 解析程序处理它们。

对于处于捕获模式的表,连接器不仅将架构更改的历史记录存储在架构更改主题中,也存储在内部数据库架构历史记录主题中。内部数据库架构历史记录主题仅用于连接器,它不用于直接使用应用程序。确保需要有关架构的通知的应用程序只消耗了该模式的更改主题的信息。

永不对数据库架构历史记录进行分区。要使数据库架构历史记录主题正常工作,它必须维护连接器向其发出的事件记录的一致性全局顺序。

要确保主题不在分区中分割,请使用以下方法之一为主题设置分区计数:

-

如果您手动创建数据库模式历史记录主题,请指定分区计数

1。 -

如果您使用 Apache Kafka 代理自动创建数据库架构历史记录主题,则创建主题,将 Kafka

num.partitions配置选项 的值设置为1。

连接器发送到其架构更改主题的消息格式处于 incubating 状态,在没有通知的情况下可能会改变。

示例:发送到 Db2 连接器模式更改主题的消息

以下示例显示了 schema 更改主题中的消息。消息包含表模式的逻辑表示。

| 项 | 字段名称 | 描述 |

|---|---|---|

| 1 |

| 显示连接器处理事件的时间的可选字段。该时间基于运行 Kafka Connect 任务的 JVM 中的系统时钟。 在源对象中,ts_ms 表示数据库中更改的时间。通过将 payload.source.ts_ms 的值与 payload.ts_ms 的值进行比较,您可以确定源数据库更新和 Debezium 之间的滞后。 |

| 2 |

| 标识包含更改的数据库和 schema。 |

| 3 |

|

对于 Db2 连接器,始终为 |

| 4 |

| 包含 DDL 命令生成的模式更改的一个或多个项目的数组。 |

| 5 |

| 描述更改的类型。该值是以下之一:

|

| 6 |

| 创建、更改或丢弃的表的完整标识符。 |

| 7 |

| 应用更改后代表表元数据。 |

| 8 |

| 编写表主密钥的列列表。 |

| 9 |

| 更改表中的每个列的元数据。 |

| 10 |

| 每个表更改的自定义属性元数据。 |

在连接器发送到 schema 更改主题的消息中,message 键是包含架构更改的数据库的名称。在以下示例中,payload 字段包含键:

3.2.5. Debezium Db2 连接器生成的事件代表事务边界

Debezium 可以生成代表事务边界的事件,并增强更改数据事件消息。

Debezium 仅在部署连接器后为发生的事务注册并接收元数据。部署连接器前发生的事务元数据。

Debezium 为每个事务生成 BEGIN 和 END 分隔符的事务边界事件。事务边界事件包含以下字段:

status-

BEGIN或END。 id- 唯一事务标识符的字符串表示。

ts_ms-

数据源上事务边界事件(

BEGIN或END事件)的时间。如果数据源没有向 Debezium 提供事件时间,则该字段代表 Debezium 处理事件的时间。 event_count(用于END事件)- 事务所设计的事件总数。

data_collections(用于END事件)-

data_collection和event_count元素的一组对,指示连接器为来自数据收集的更改发出的事件数。

示例

除非通过 topic.transaction 选项覆盖,否则连接器会将事务事件发送到 < topic.prefix>.transaction 主题。

数据更改事件增强

当启用事务元数据时,连接器会使用新的 transaction 字段增强更改事件 Envelope。此字段以字段复合的形式提供有关每个事件的信息:

id- 唯一事务标识符的字符串表示。

total_order- 事件在事务生成的所有事件的绝对路径。

data_collection_order- 事件在事务发送的所有事件中每个数据收集位置。

以下是消息的示例:

3.3. Debezium Db2 连接器数据更改事件的描述

Debezium Db2 连接器会为每行级别 INSERT、UPDATE 和 DELETE 操作生成数据更改事件。每个事件都包含一个键和值。键和值的结构取决于更改的表。

Debezium 和 Kafka Connect 围绕 事件消息的持续流 设计。但是,这些事件的结构可能会随时间而变化,而用户很难处理这些事件。要解决这个问题,每个事件都包含其内容的 schema,或者如果您使用 schema registry,则消费者可以从 registry 获取 schema 的模式 ID。这使得每个事件都可以自我包含。

以下框架 JSON 显示更改事件的基本四个部分。但是,如何配置在应用程序中使用的 Kafka Connect converter 决定了更改事件中的这四个部分的表示。只有当您将转换器配置为生成它时,schema 字段才处于更改事件中。同样,只有在将转换器配置为生成它时,才会发生更改事件中的事件密钥和事件有效负载。如果您使用 JSON 转换器,并将其配置为生成所有四个基本更改事件部分,则更改事件具有此结构:

| 项 | 字段名称 | 描述 |

|---|---|---|

| 1 |

|

第一个 |

| 2 |

|

第一个 |

| 3 |

|

第二个 |

| 4 |

|

第二个 |

默认情况下,连接器流将事件记录更改为名称与事件原始表相同的名称的主题。如需更多信息,请参阅 主题名称。

Debezium Db2 连接器确保所有 Kafka Connect 模式名称都遵循 Avro 模式名称格式。这意味着,逻辑服务器名称必须以拉丁或下划线开头,即 a-z、A-Z 或 _。逻辑服务器名称中的每个剩余的字符以及数据库和表名称中的每个字符都必须是字母、数字或下划线,即 a-z、A-Z、0-9 或 \_。如果存在无效的字符,它将替换为下划线字符。

如果逻辑服务器名称、数据库名称或表名称包含无效字符,且区分另一个名称的唯一字符无效,则可能会导致意外冲突,因此替换为下划线。

另外,对于数据库、模式和表的 Db2 名称可能区分大小写。这意味着连接器可能会向同一 Kafka 主题发出多个表的事件记录。

详情包括在以下主题中:

3.3.1. 关于 Debezium db2 中的键更改事件

更改事件的密钥包含更改表的密钥的 schema,以及更改的行的实际键。在连接器创建事件时,模式及其对应有效负载都包含更改表的 PRIMARY KEY (或唯一约束)中的每个列的字段。

请考虑以下 客户 表,然后是此表的更改事件键示例。

表示例

更改事件键示例

捕获对 customers 表的更改的每个更改事件都有相同的事件键模式。只要 表有以前的定义,捕获 customer 表更改的事件都有以下关键结构:在 JSON 中,它类似如下:

customers

| 项 | 字段名称 | 描述 |

|---|---|---|

| 1 |

|

键的 schema 部分指定一个 Kafka Connect 模式,它描述了密钥 |

| 2 |

|

指定 |

| 3 |

|

指明 event 键必须在其 |

| 4 |

|

定义密钥有效负载结构的 schema 名称。这个模式描述了更改的表的主键的结构。键架构名称的格式为 connector-name.database-name.table-name.

|

| 5 |

|

包含生成此更改事件的行的键。在本例中,键包含一个 |

3.3.2. 关于 Debezium Db2 更改事件中的值

更改事件中的值比键稍微复杂。与键一样,该值具有 schema 部分和 payload 部分。schema 部分包含描述 payload 部分的 Envelope 结构的 schema,包括其嵌套字段。更改创建、更新或删除数据的事件,并且具有 envelope 结构的值有效负载。

考虑用于显示更改事件键示例的相同示例:

表示例

customers 表的每个更改事件的事件值部分都指定了相同的模式。事件值的有效负载因事件类型而异:

创建 事件

以下示例显示了连接器为在 customer 表中创建数据的操作生成的更改事件的值部分:

| 项 | 字段名称 | 描述 |

|---|---|---|

| 1 |

| 值的 schema,用于描述值有效负载的结构。每次连接器为特定表生成的更改时,更改事件的值模式都是相同的。 |

| 2 |

|

在 |

| 3 |

|

|

| 4 |

|

|

| 5 |

|

值的实际数据。这是更改事件提供的信息。 |

| 6 |

|

指定事件发生前行状态的可选字段。当 |

| 7 |

|

指定事件发生后行状态的可选字段。在本例中, |

| 8 |

|

描述事件源元数据的必需字段。

|

| 9 |

|

描述导致连接器生成事件的操作类型的必要字符串。在本例中,

|

| 10 |

|

显示连接器处理事件的时间的可选字段。该时间基于运行 Kafka Connect 任务的 JVM 中的系统时钟。 |

更新 事件

示例 customer 表中更新的更改事件值与该表的 create 事件相同。同样,update 事件值的有效负载具有相同的结构。但是,事件值 payload 在更新 事件中包含不同的值。以下是连接器在 customers 表中为更新生成的更改事件值示例:

| 项 | 字段名称 | 描述 |

|---|---|---|

| 1 |

|

指定事件发生前行状态的可选字段。在 update 事件值中, |

| 2 |

|

指定事件发生后行状态的可选字段。您可以比较 |

| 3 |

|

描述事件源元数据的必需字段。

|

| 4 |

|

描述操作类型的强制字符串。在 update 事件值中, |

| 5 |

|

显示连接器处理事件的时间的可选字段。该时间基于运行 Kafka Connect 任务的 JVM 中的系统时钟。 |

更新行的主/唯一键的列会更改行键的值。当键更改时,Debebe 会输出 三个 事件: DELETE 事件和带有行的旧键的 tombstone 事件,后跟带有行的新键的事件。

删除 事件

delete 更改事件中的值与为同一表的 create 和 update 事件相同的 schema 部分。示例 customer 表的 delete 事件中的事件值 payload 类似如下:

| 项 | 字段名称 | 描述 |

|---|---|---|

| 1 |

|

指定事件发生前行状态的可选字段。在一个 delete 事件值中, |

| 2 |

|

指定事件发生后行状态的可选字段。在 delete 事件值中, |

| 3 |

|

描述事件源元数据的必需字段。在一个 delete 事件值中,

|

| 4 |

|

描述操作类型的强制字符串。 |

| 5 |

|

显示连接器处理事件的时间的可选字段。该时间基于运行 Kafka Connect 任务的 JVM 中的系统时钟。 |

删除 更改事件记录为消费者提供处理此行删除所需的信息。包括了旧值,因为有些使用者可能需要它们才能正确处理删除。

Db2 连接器事件旨在用于 Kafka 日志压缩。只要每个密钥至少保留最新的消息,日志压缩就可以删除一些旧的消息。这可让 Kafka 回收存储空间,同时确保主题包含完整的数据集,并可用于重新载入基于密钥的状态。

删除行时,delete 事件值仍可用于日志压缩,因为 Kafka 您可以删除具有相同键的所有之前信息。但是,如果 Kafka 删除具有相同键的所有消息,消息值必须是 null。为了实现此目的,在 Debezium 的 Db2 连接器发出 delete 事件后,连接器会发出一个特殊的 tombstone 事件,它具有相同的键有一个 null 值 。

3.4. Debezium Db2 连接器如何映射数据类型

Db2 的数据类型在 Db2 SQL 数据类型 中进行了描述。

Db2 连接器代表对带有类似于行存在的表的事件的更改。event 包含每个列值的字段。该值在事件中如何代表取决于该列的 Db2 数据类型。这部分论述了这些映射。如果默认数据类型转换无法满足您的需要,您可以为连接器 创建自定义转换器。

详情包括在以下部分:

基本类型

下表描述了连接器如何将每个 Db2 数据类型映射到 字面类型和 事件字段中 的语义类型。

-

literal type 描述了如何使用 Kafka Connect 模式类型来表示:

INT8,INT16,INT32,INT64,FLOAT32,FLOAT64,BOOLEAN,STRING,BYTES, ARRAY,MAP, 和STRUCT。 - 语义类型 描述了 Kafka Connect 模式如何使用字段名称来捕获字段 的含义。

| Db2 数据类型 | 字面类型(架构类型) | 语义类型(架构名称)和备注 |

|---|---|---|

|

|

| 只能从具有 BOOLEAN 类型列的表中获取快照。目前,Db2 上的 SQL Replication 不支持 BOOLEAN,因此 Debezium 无法在这些表上执行 CDC。考虑使用不同的类型。 |

|

|

| 不适用 |

|

|

| 不适用 |

|

|

| 不适用 |

|

|

| 不适用 |

|

|

| 不适用 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 不适用 |

|

|

| 不适用 |

|

|

| 不适用 |

|

|

| 不适用 |

|

|

| 不适用 |

|

|

|

|

|

|

|

|

|

|

| 不适用 |

|

|

| 不适用 |

|

|

| 不适用 |

|

|

|

|

如果存在,列的默认值会被传播到对应的字段的 Kafka Connect 模式。更改事件包含字段的默认值,除非给出了显式列值。因此,很少需要从 schema 获取默认值。

临时类型

除 Db2 的 DATETIMEOFFSET 数据类型外,其中包含时区信息,如何映射 temporal 类型取决于 time.precision.mode 连接器配置属性的值。以下小节描述了这些映射:

time.precision.mode=adaptive

当 time.precision.mode 配置属性设为 adaptive 时,默认连接器根据列的数据类型定义决定字面类型和语义类型。这样可确保事件 完全 表示数据库中的值。

| Db2 数据类型 | 字面类型(架构类型) | 语义类型(架构名称)和备注 |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

time.precision.mode=connect

当 time.precision.mode 配置属性设为 connect 时,连接器将使用 Kafka Connect 逻辑类型。当消费者只能处理内置的 Kafka Connect 逻辑类型且无法处理变量精度时间值时,这很有用。但是,因为 Db2 支持十分之一微秒的精度,使用 connect 时间精度的连接器会在数据库列带有 fractional second precision 值大于 3 时,导致精度下降。

| Db2 数据类型 | 字面类型(架构类型) | 语义类型(架构名称)和备注 |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

时间戳类型

DATETIME 类型代表没有时区信息的时间戳。这些列根据 UTC 转换为等同的 Kafka Connect 值。例如,DATETIME 值 "2018-06-20 15:13:16.945104" 由 io.debezium.time.Timestamp 代表,值为 "1539)07596000"。

运行 Kafka Connect 和 Debezium 的 JVM 的时区不会影响这个转换。

| Db2 数据类型 | 字面类型(架构类型) | 语义类型(架构名称)和备注 |

|---|---|---|

|

|

|

|

|

|

|

|

3.5. 设置 Db2 以运行 Debezium 连接器

要使 Debezium 捕获提交到 Db2 表的更改事件,具有所需特权的 Db2 数据库管理员必须在数据库中配置表以更改数据捕获。开始运行 Debezium 后,您可以调整捕获代理的配置以优化性能。

有关为 Debezium 连接器设置 Db2 的详情,请查看以下部分:

3.5.1. 配置 Db2 表以更改数据捕获

要将表置于捕获模式,Debezium 提供了一组用户定义的功能(UDF)。此处的步骤演示了如何安装和运行这些管理 UDF。或者,您可以运行 Db2 控制命令将表置于捕获模式。然后,管理员必须为希望 Debezium 捕获的每个表启用 CDC。

先决条件

-

以

db2instl用户身份登录 Db2。 - 在 Db2 主机上,Debebe 管理 UDF 在 $HOME/asncdctools/src 目录中提供。UDF 可从 Debezium 示例存储库 获得。

流程

使用 Db2 提供的

bldrtn命令编译 Db2 服务器主机上的 Debezium 管理 UDF:cd $HOME/asncdctools/src

cd $HOME/asncdctools/srcCopy to Clipboard Copied! Toggle word wrap Toggle overflow ./bldrtn asncdc

./bldrtn asncdcCopy to Clipboard Copied! Toggle word wrap Toggle overflow 启动数据库(如果还没有运行)。将

DB_NAME替换为您希望 Debezium 连接到的数据库的名称。db2 start db DB_NAME

db2 start db DB_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 确保 JDBC 可以读取 Db2 元数据目录:

cd $HOME/sqllib/bnd

cd $HOME/sqllib/bndCopy to Clipboard Copied! Toggle word wrap Toggle overflow db2 bind db2schema.bnd blocking all grant public sqlerror continue

db2 bind db2schema.bnd blocking all grant public sqlerror continueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 确保数据库最近备份。ASN 代理必须具有从中读取的最新起点。如果您需要执行备份,请运行以下命令,它会修剪数据,以便只有最新版本可用。如果您不不需要保留旧版本的数据,请为备份位置指定

dev/null。备份数据库。将

DB_NAME和BACK_UP_LOCATION替换为适当的值:db2 backup db DB_NAME to BACK_UP_LOCATION

db2 backup db DB_NAME to BACK_UP_LOCATIONCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重启数据库:

db2 restart db DB_NAME

db2 restart db DB_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow

连接到数据库,以安装 Debezium 管理 UDF。假设您以

db2instl用户身份登录,因此应在db2inst1用户上安装 UDF。db2 connect to DB_NAME

db2 connect to DB_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 复制 Debezium 管理 UDF 并为它们设置权限:

cp $HOME/asncdctools/src/asncdc $HOME/sqllib/function

cp $HOME/asncdctools/src/asncdc $HOME/sqllib/functionCopy to Clipboard Copied! Toggle word wrap Toggle overflow chmod 777 $HOME/sqllib/function

chmod 777 $HOME/sqllib/functionCopy to Clipboard Copied! Toggle word wrap Toggle overflow 启用用于启动和停止 ASN 捕获代理的 Debezium UDF:

db2 -tvmf $HOME/asncdctools/src/asncdc_UDF.sql

db2 -tvmf $HOME/asncdctools/src/asncdc_UDF.sqlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 ASN 控制表:

db2 -tvmf $HOME/asncdctools/src/asncdctables.sql

$ db2 -tvmf $HOME/asncdctools/src/asncdctables.sqlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 启用 Debezium UDF 来添加表来捕获模式并从捕获模式中删除表:

db2 -tvmf $HOME/asncdctools/src/asncdcaddremove.sql

$ db2 -tvmf $HOME/asncdctools/src/asncdcaddremove.sqlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 设置 Db2 服务器后,使用 UDF 使用 SQL 命令控制 Db2 复制(ASN)。有些 UDF 期望一个返回值,在这种情况下,您可以使用 SQL

VALUE语句来调用它们。对于其他 UDF,请使用 SQLCALL语句。启动 ASN 代理:

VALUES ASNCDC.ASNCDCSERVICES('start','asncdc');VALUES ASNCDC.ASNCDCSERVICES('start','asncdc');Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以上语句返回以下结果之一:

-

asncap 已在运行 start --><COMMAND>在这种情况下,在终端窗口中输入指定的

<COMMAND>,如下例所示:/database/config/db2inst1/sqllib/bin/asncap capture_schema=asncdc capture_server=SAMPLE &

/database/config/db2inst1/sqllib/bin/asncap capture_schema=asncdc capture_server=SAMPLE &Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

将表置于捕获模式。对您要放入捕获的每个表调用以下语句:将

MYSCHEMA替换为包含您要放入捕获模式的表的 schema 名称。同样,将MYTABLE替换为要放入捕获模式的表名称:CALL ASNCDC.ADDTABLE('MYSCHEMA', 'MYTABLE');CALL ASNCDC.ADDTABLE('MYSCHEMA', 'MYTABLE');Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重新初始化 ASN 服务:

VALUES ASNCDC.ASNCDCSERVICES('reinit','asncdc');VALUES ASNCDC.ASNCDCSERVICES('reinit','asncdc');Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5.2. Db2 捕获代理配置对服务器负载和延迟的影响

当数据库管理员为源表启用数据捕获时,捕获代理开始运行。代理从事务日志中读取新的更改事件记录,并将事件记录复制到捕获表中。在源表中提交更改的时间之间,更改在对应的更改表中出现的时间,始终会有一个小的延迟间隔。这个延迟间隔代表了在源表中更改时以及 Debezium 被流传输到 Apache Kafka 间的差距。

理想情况下,对于必须快速响应数据更改的应用程序,您希望在源和捕获表之间保持同步。您可能希望运行捕获代理来持续处理更改事件,可能会导致吞吐量增加吞吐量,并减少在事件发生后尽快使用新的事件记录更改表。然而,这不一定是这种情况。在更直接同步时,会牺牲性能损失。每次更改代理查询数据库是否有新的事件记录时,它会增加数据库主机上的 CPU 负载。服务器上的额外负载可能会对整体数据库性能造成负面影响,并可能会降低事务效率,特别是在峰值数据库使用期间。

监控数据库指标非常重要,以便您知道数据库是否达到服务器不再支持捕获代理级别的活动点。如果您在运行捕获代理时遇到问题,请调整捕获代理设置,以减少 CPU 负载。

3.5.3. Db2 捕获代理配置参数

在 Db2 上,IBMSNAP_CAPPARMS 表包含控制捕获代理行为的参数。您可以调整这些参数的值,以平衡捕获过程的配置,以减少 CPU 负载并仍然维护可接受的延迟级别。

有关如何配置 Db2 捕获代理参数的具体指导超出了本文档的范围。

在 IBMSNAP_CAPPARMS 表中,以下参数对降低 CPU 负载有最大的效果:

COMMIT_INTERVAL- 指定捕获代理等待将数据提交到更改数据的秒数。

- 数值越大可减少数据库主机上的负载并增加延迟。

-

默认值为

30。

SLEEP_INTERVAL- 指定捕获代理在达到活跃事务日志结束后等待启动新提交周期的秒数。

- 数值越大可减少服务器上的负载,并增加延迟。

-

默认值为

5。

其他资源

- 有关捕获代理参数的更多信息,请参阅 Db2 文档。

3.6. 部署 Debezium Db2 连接器

您可以使用以下任一方法部署 Debezium Db2 连接器:

由于许可要求,Debebe Db2 连接器存档不包括 Debezium 连接到 Db2 数据库所需的 Db2 JDBC 驱动程序。要启用连接器访问数据库,您必须将驱动程序添加到连接器环境中。有关如何获取驱动程序的详情,请参考包含 Db2 JDBC 驱动程序。

3.6.1. 获取 Db2 JDBC 驱动程序

由于许可证的要求,Debezium 连接到一个 Db2 数据库所需的 Db2 JDBC 驱动程序文件没有包括在 Debezium Db2 连接器存档中。驱动程序可从 Maven Central 下载。根据您使用的部署方法,您可以通过向 Kafka Connect 自定义资源或您用来构建连接器镜像的 Dockerfile 来检索驱动程序。

-

如果您使用 AMQ Streams 将连接器添加到 Kafka Connect 镜像中,请将驱动程序的 Maven Central 位置添加到

KafkaConnect自定义资源的builds.plugins.artifact.url中,如 第 3.6.3 节 “使用 AMQ Streams 部署 Debezium Db2 连接器” 所示。 -

如果您使用 Dockerfile 为连接器构建容器镜像,请在 Dockerfile 中插入

curl命令以指定从 Maven Central 下载所需驱动程序文件的 URL。更多信息请参阅 第 3.6.4 节 “通过从 Dockerfile 构建自定义 Kafka Connect 容器镜像来部署 Debezium Db2 连接器”。

3.6.2. 使用 AMQ Streams 部署 Db2 连接器

从 Debezium 1.7 开始,部署 Debezium 连接器的首选方法是使用 AMQ Streams 来构建包含连接器插件的 Kafka Connect 容器镜像。

在部署过程中,您可以创建并使用以下自定义资源(CR):

-

定义 Kafka Connect 实例的

KafkaConnectCR,并包含有关镜像中需要包含连接器工件的信息。 -

提供连接器用来访问源数据库的信息的

KafkaConnectorCR。在 AMQ Streams 启动 Kafka Connect pod 后,您可以通过应用KafkaConnectorCR 来启动连接器。

在 Kafka Connect 镜像的构建规格中,您可以指定可用于部署的连接器。对于每个连接器插件,您还可以指定您的部署可以使用的其他组件。例如,您可以添加 Apicurio Registry 工件或 Debezium 脚本组件。当 AMQ Streams 构建 Kafka Connect 镜像时,它会下载指定的工件,并将其合并到镜像中。

KafkaConnect CR 中的 spec.build.output 参数指定存储生成的 Kafka Connect 容器镜像的位置。容器镜像可以存储在 Docker registry 中,也可以存储在 OpenShift ImageStream 中。要将镜像存储在 ImageStream 中,您必须先创建 ImageStream,然后才能部署 Kafka Connect。镜像流不会被自动创建。

如果使用 KafkaConnect 资源创建集群,之后您无法使用 Kafka Connect REST API 创建或更新连接器。您仍然可以使用 REST API 来检索信息。

其他资源

- 在 OpenShift 上使用 AMQ Streams 配置 Kafka 连接。

- 在 OpenShift 中部署和升级 AMQ Streams 中的使用 AMQ Streams 自动创建新容器镜像。

3.6.3. 使用 AMQ Streams 部署 Debezium Db2 连接器

使用早期版本的 AMQ Streams 时,要在 OpenShift 上部署 Debezium 连接器,首先需要为连接器构建 Kafka Connect 镜像。在 OpenShift 上部署连接器的当前首选的方法是使用 AMQ Streams 中的构建配置来自动构建 Kafka Connect 容器镜像,其中包含您要使用的 Debezium 连接器插件。

在构建过程中,AMQ Streams Operator 会将 KafkaConnect 自定义资源中的输入参数(包括 Debezium 连接器定义)转换为 Kafka Connect 容器镜像。构建从 Red Hat Maven 存储库或其他配置的 HTTP 服务器下载必要的工件。

新创建的容器被推送到 .spec.build.output 中指定的容器 registry,用于部署 Kafka Connect 集群。AMQ Streams 构建 Kafka Connect 镜像后,您可以创建 KafkaConnector 自定义资源来启动构建中包含的连接器。

先决条件

- 您可以访问安装了集群 Operator 的 OpenShift 集群。

- AMQ Streams Operator 正在运行。

- 部署 Apache Kafka 集群,如在 OpenShift 中部署和升级 AMQ Streams 所述。

- Kafka Connect 部署在 AMQ Streams 上

- 您有红帽构建的 Debezium 许可证。

-

已安装 OpenShift

ocCLI 客户端,或者您可以访问 OpenShift Container Platform Web 控制台。 根据您要存储 Kafka Connect 构建镜像的方式,您需要 registry 权限或您必须创建 ImageStream 资源:

- 要将构建镜像存储在镜像 registry 中,如 Red Hat Quay.io 或 Docker Hub

- 在 registry 中创建和管理镜像的帐户和权限。

- 将构建镜像存储为原生 OpenShift ImageStream

- ImageStream 资源已部署到集群中,以存储新的容器镜像。您必须为集群明确创建 ImageStream。镜像流默认不可用。如需有关 ImageStreams 的更多信息,请参阅在 OpenShift Container Platform 上管理镜像流。

流程

- 登录 OpenShift 集群。

为连接器创建 Debezium

KafkaConnect自定义资源(CR),或修改现有的资源。例如,创建一个名为dbz-connect.yaml的KafkaConnectCR,用于指定metadata.annotations和spec.build属性。以下示例显示了来自dbz-connect.yaml文件的摘录,该文件描述了KafkaConnect自定义资源。

例 3.1.

dbz-connect.yaml文件,该文件定义包含 Debezium 连接器的KafkaConnect自定义资源在以下示例中,自定义资源被配置为下载以下工件:

- Debezium Db2 连接器存档。

- 红帽构建的 Apicurio Registry 存档。Apicurio Registry 是一个可选组件。只有在打算在连接器中使用 Avro 序列化时,才添加 Apicurio Registry 组件。

- Debezium 脚本 SMT 归档以及您要与 Debezium 连接器一起使用的相关语言依赖项。SMT 归档和语言依赖项是可选组件。只有在打算使用 Debezium 是 基于内容的路由 SMT 或 过滤 SMT 时,才添加这些组件。

- Db2 JDBC 驱动程序需要连接到 Db2 数据库,但不包含在连接器存档中。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Expand 表 3.14. Kafka Connect 配置设置的描述 项 描述 1

将

strimzi.io/use-connector-resources注解设置为"true",以便 Cluster Operator 使用KafkaConnector资源在此 Kafka Connect 集群中配置连接器。2

spec.build配置指定构建镜像的位置,并列出要在镜像中包含的插件,以及插件工件的位置。3

build.output指定存储新构建镜像的 registry。4

指定镜像输出的名称和镜像名称。

output.type的有效值是docker,可推送到容器 registry,如 Docker Hub 或 Quay,或将镜像推送到内部 OpenShift ImageStream的镜像流。要使用 ImageStream,必须将 ImageStream 资源部署到集群中。有关在 KafkaConnect 配置中指定build.output的更多信息,请参阅在 OpenShift 中配置 AMQ Streams 中的 AMQ Streams Build schema 参考。5

插件配置列出了您要包含在 Kafka Connect 镜像中的所有连接器。对于列表中的每个条目,指定一个插件名称,以及有关构建连接器所需的工件的信息。另外,对于每个连接器插件,您还可以包含您要与连接器一起使用的其他组件。例如,您可以添加 Service Registry 工件或 Debezium 脚本组件。6

artifacts.type的值指定artifacts.url中指定的工件的文件类型。有效类型是zip、tgz或jar。Debezium 连接器存档以.zip文件格式提供。JDBC 驱动程序文件采用.jar格式。type值必须与url字段中引用的文件类型匹配。7

artifacts.url的值指定 HTTP 服务器的地址,如 Maven 存储库,用于存储连接器工件的文件。OpenShift 集群必须有权访问指定的服务器。8

(可选)指定用于下载 Apicurio Registry 组件的工件

类型和url。包括 Apicurio Registry 工件,只有在您希望连接器使用 Apache Avro 与 Red Hat build of Apicurio Registry 序列化事件键和值时,而不是使用默认的 JSON converter。9

(可选)指定 Debezium 脚本 SMT 归档的工件

类型和url,以用于 Debezium 连接器。只有在打算使用 Debezium 基于内容的路由 SMT 或 过滤 SMT 时使用脚本 SMT 时,才包含脚本 SMT,您必须部署 JSR 223 兼容脚本实施,如 groovy。10

(可选)为 JSR 223 兼容脚本实现的 JAR 文件指定工件

类型和url,这是 Debezium 脚本 SMT 所需的。重要如果您使用 AMQ Streams 将连接器插件合并到 Kafka Connect 镜像中,对于每个所需脚本语言组件,则

artifacts.url必须指定 JAR 文件的位置,而artifacts.type的值还必须设置为jar。无效的值会导致连接器在运行时失败。要启用使用带有脚本 SMT 的 Apache Groovy 语言,示例中的自定义资源会检索以下库的 JAR 文件:

-

groovy -

Groovy-jsr223(协调代理) -

Groovy-json(用于解析 JSON 字符串的模块)

Debezium 脚本 SMT 还支持使用 GraalVM JavaScript 的 JSR 223 实现。

11

指定 Maven Central 中的 Db2 JDBC 驱动程序的位置。Debezium Db2 连接器存档中没有包括所需的驱动程序。

输入以下命令将

KafkaConnect构建规格应用到 OpenShift 集群:oc create -f dbz-connect.yaml

oc create -f dbz-connect.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 根据自定义资源中指定的配置,Streams Operator 会准备要部署的 Kafka Connect 镜像。

构建完成后,Operator 将镜像推送到指定的 registry 或 ImageStream,并启动 Kafka Connect 集群。您配置中列出的连接器工件在集群中可用。创建一个

KafkaConnector资源来定义您要部署的每个连接器的实例。

例如,创建以下KafkaConnectorCR,并将它保存为db2-inventory-connector.yaml例 3.2. 为 Debezium 连接器定义

KafkaConnector自定义资源的db2-inventory-connector.yaml文件Copy to Clipboard Copied! Toggle word wrap Toggle overflow Expand 表 3.15. 连接器配置设置的描述 项 描述 1

使用 Kafka Connect 集群注册的连接器名称。

2

连接器类的名称。

3

可同时运行的任务数量。

4

连接器的配置。

5

主机数据库实例的地址。

6

数据库实例的端口号。

7

Debezium 用于连接到数据库的帐户名称。

8

Debezium 用于连接到数据库用户帐户的密码。

9

要从中捕获更改的数据库名称。

10

数据库实例或集群的主题前缀。

指定的名称只能从字母数字字符或下划线括起。

由于主题前缀用作从这个连接器接收更改事件的任何 Kafka 主题的前缀,所以名称必须在集群中的连接器之间唯一。

此命名空间也用于相关的 Kafka Connect 模式的名称,如果您将连接器与 Avro 连接器集成,则对应的 Avro 模式的命名空间也用于。11

连接器从中捕获更改事件的表列表。

运行以下命令来创建连接器资源:

oc create -n <namespace> -f <kafkaConnector>.yaml

oc create -n <namespace> -f <kafkaConnector>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例如,

oc create -n debezium -f {context}-inventory-connector.yamloc create -n debezium -f {context}-inventory-connector.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 连接器注册到 Kafka Connect 集群,并开始针对

KafkaConnectorCR 中的spec.config.database.dbname指定的数据库运行。连接器 pod 就绪后,Debezium 正在运行。

您现在已准备好 验证 Debezium Db2 部署。

要部署 Debezium Db2 连接器,您必须构建包含 Debezium 连接器存档的自定义 Kafka Connect 容器镜像,然后将此容器镜像推送到容器 registry。然后,您需要创建以下自定义资源(CR):

-

定义 Kafka Connect 实例的

KafkaConnectCR。CR 中的image属性指定您创建用来运行 Debezium 连接器的容器镜像的名称。您可以将此 CR 应用到部署了 Red Hat AMQ Streams 的 OpenShift 实例。AMQ Streams 提供将 Apache Kafka 引入到 OpenShift 的 operator 和镜像。 -

定义 Debezium Db2 连接器的

KafkaConnectorCR。将此 CR 应用到应用KafkaConnectCR 的相同 OpenShift 实例。

先决条件

- Db2 正在运行,您完成了 设置 Db2 的步骤以用于 Debezium 连接器。

- AMQ Streams 部署在 OpenShift 上,并运行 Apache Kafka 和 Kafka Connect。如需更多信息,请参阅在 OpenShift 中部署和升级 AMQ Streams。

- podman 或 Docker 已安装。

- Kafka Connect 服务器有权访问 Maven Central 来下载 Db2 所需的 JDBC 驱动程序。您还可以使用驱动程序的本地副本,或者从本地 Maven 存储库或其他 HTTP 服务器提供。

-

您有在容器 registry 中创建和管理容器(如

quay.io或docker.io)的帐户和权限,您要向其添加将运行 Debezium 连接器的容器。

流程

为 Kafka Connect 创建 Debezium Db2 容器:

创建一个 Dockerfile,它使用

registry.redhat.io/amq7/amq-streams-kafka-32-rhel8:2.2.0-12作为基础镜像。例如,在终端窗口中输入以下命令:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Expand 项 描述 1

您可以指定您想要的任何文件名。

2

指定 Kafka Connect 插件目录的路径。如果您的 Kafka Connect 插件目录位于不同的位置,请将这个路径替换为您的目录的实际路径。

该命令在当前目录中创建一个名为

debezium-container-for-db2.yaml的 Dockerfile。从您在上一步中创建的

debezium-container-for-db2.yamlDocker 文件中构建容器镜像。在包含该文件的目录中,打开终端窗口并输入以下命令之一:podman build -t debezium-container-for-db2:latest .

podman build -t debezium-container-for-db2:latest .Copy to Clipboard Copied! Toggle word wrap Toggle overflow docker build -t debezium-container-for-db2:latest .

docker build -t debezium-container-for-db2:latest .Copy to Clipboard Copied! Toggle word wrap Toggle overflow 上述命令使用名称

debezium-container-for-db2构建容器镜像。将自定义镜像推送到容器 registry,如 quay.io 或内部容器 registry。容器 registry 必须可供部署镜像的 OpenShift 实例使用。输入以下命令之一:

podman push <myregistry.io>/debezium-container-for-db2:latest

podman push <myregistry.io>/debezium-container-for-db2:latestCopy to Clipboard Copied! Toggle word wrap Toggle overflow docker push <myregistry.io>/debezium-container-for-db2:latest

docker push <myregistry.io>/debezium-container-for-db2:latestCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建新的 Debezium Db2

KafkaConnect自定义资源(CR)。例如,创建一个名为dbz-connect.yaml的KafkaConnectCR,用于指定注解和镜像属性。以下示例显示了来自dbz-connect.yaml文件的摘录,该文件描述了KafkaConnect自定义资源。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Expand 项 描述 1

metadata.annotations表示KafkaConnector资源用于配置在这个 Kafka Connect 集群中使用的 Cluster Operator。2

spec.image指定您为运行 Debezium 连接器而创建的镜像名称。此属性覆盖 Cluster Operator 中的STRIMZI_DEFAULT_KAFKA_CONNECT_IMAGE变量。输入以下命令将

KafkaConnectCR 应用到 OpenShift Kafka Connect 环境:oc create -f dbz-connect.yaml

oc create -f dbz-connect.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 命令添加一个 Kafka Connect 实例,用于指定您为运行 Debezium 连接器而创建的镜像名称。

创建一个

KafkaConnector自定义资源来配置 Debezium Db2 连接器实例。您可以在

.yaml文件中配置 Debezium Db2 连接器,该文件指定连接器的配置属性。连接器配置可能会指示 Debezium 为 schema 和表的子集生成事件,或者可能会设置属性,以便 Debezium 忽略敏感、太大或不需要的指定栏中的值。以下示例配置了 Debezium 连接器,该连接器连接到 Db2 服务器主机

192.168.99.100,端口50000。此主机有一个名为mydatabase的数据库,名为 inventory 的表,inventory-connector-db2Db2

inventory-connector.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Expand 表 3.16. 连接器配置设置的描述 项 描述 1

在将连接器注册到 Kafka Connect 集群时,它的名称。

2

此 Db2 连接器类的名称。

3

任何时候只能有一个任务。

4

连接器的配置。

5

数据库主机,它是 Db2 实例的地址。

6

Db2 实例的端口号。

7

Db2 用户的名称。

8

Db2 用户的密码。

9

要从中捕获更改的数据库名称。

10

Db2 实例/集群的逻辑名称,它组成一个命名空间,用于连接器写入的 Kafka 主题名称、Kafka Connect 模式的名称以及在使用 Avro Connector 时对应 Avro 模式的命名空间。

11

连接器仅捕获来自

public.inventory表中的更改。使用 Kafka Connect 创建连接器实例。例如,如果您将

KafkaConnector资源保存到inventory-connector.yaml文件中,您将运行以下命令:oc apply -f inventory-connector.yaml

oc apply -f inventory-connector.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 上述命令注册

inventory-connector,连接器开始针对KafkaConnectorCR 中定义的mydatabase数据库运行。

有关您可以为 Debezium Db2 连接器设置的配置属性的完整列表,请参阅 Db2 连接器属性。

结果

连接器启动后,它会对连接器配置为捕获更改的 Db2 数据库表 执行一致的快照。然后,连接器开始为行级操作生成数据更改事件,并将事件记录流传输到 Kafka 主题。

3.6.5. 验证 Debezium Db2 连接器正在运行

如果连接器正确启动且没有错误,它会为每个连接器配置为捕获的表创建一个主题。下游应用程序可以订阅这些主题以检索源数据库中发生的信息事件。

要验证连接器是否正在运行,您可以从 OpenShift Container Platform Web 控制台或 OpenShift CLI 工具(oc)执行以下操作:

- 验证连接器状态。

- 验证连接器是否生成主题。

- 验证主题是否填充了每个表初始快照过程中生成的读操作("op":"r")的事件。

先决条件

- Debezium 连接器部署到 OpenShift 上的 AMQ Streams。

-

已安装 OpenShift

ocCLI 客户端。 - 访问 OpenShift Container Platform web 控制台。

流程

使用以下方法之一检查

KafkaConnector资源的状态:在 OpenShift Container Platform Web 控制台中:

- 导航到 Home → Search。

-

在 Search 页面中,点 Resources 以打开 Select Resource 复选框,然后键入

KafkaConnector。 - 在 KafkaConnectors 列表中,点您要检查的连接器的名称,如 inventory-connector-db2。

- 在 Conditions 部分中,验证 Type 和 Status 列中的值是否已设置为 Ready 和 True。

在一个终端窗口中:

使用以下命令:

oc describe KafkaConnector <connector-name> -n <project>

oc describe KafkaConnector <connector-name> -n <project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如,

oc describe KafkaConnector inventory-connector-db2 -n debezium

oc describe KafkaConnector inventory-connector-db2 -n debeziumCopy to Clipboard Copied! Toggle word wrap Toggle overflow 该命令返回类似以下输出的状态信息:

例 3.3.

KafkaConnector资源状态Copy to Clipboard Copied! Toggle word wrap Toggle overflow

验证连接器是否已创建 Kafka 主题:

通过 OpenShift Container Platform Web 控制台。

- 导航到 Home → Search。

-

在 Search 页面中,点 Resources 打开 Select Resource 复选框,然后键入

KafkaTopic。 -

在 KafkaTopics 列表中,点您要检查的主题的名称,例如

inventory-connector-db2.inventory.orders--ac5e98ac6a5d91e04d8ec0dc9078a1ece439081d。 - 在 Conditions 部分中,验证 Type 和 Status 列中的值是否已设置为 Ready 和 True。

在一个终端窗口中:

使用以下命令:

oc get kafkatopics

oc get kafkatopicsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 该命令返回类似以下输出的状态信息:

例 3.4.

KafkaTopic资源状态Copy to Clipboard Copied! Toggle word wrap Toggle overflow

检查主题内容。

- 在终端窗口中输入以下命令:

oc exec -n <project> -it <kafka-cluster> -- /opt/kafka/bin/kafka-console-consumer.sh \ > --bootstrap-server localhost:9092 \ > --from-beginning \ > --property print.key=true \ > --topic=<topic-name>

oc exec -n <project> -it <kafka-cluster> -- /opt/kafka/bin/kafka-console-consumer.sh \ > --bootstrap-server localhost:9092 \ > --from-beginning \ > --property print.key=true \ > --topic=<topic-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如,

oc exec -n debezium -it debezium-kafka-cluster-kafka-0 -- /opt/kafka/bin/kafka-console-consumer.sh \ > --bootstrap-server localhost:9092 \ > --from-beginning \ > --property print.key=true \ > --topic=inventory-connector-db2.inventory.products_on_hand

oc exec -n debezium -it debezium-kafka-cluster-kafka-0 -- /opt/kafka/bin/kafka-console-consumer.sh \ > --bootstrap-server localhost:9092 \ > --from-beginning \ > --property print.key=true \ > --topic=inventory-connector-db2.inventory.products_on_handCopy to Clipboard Copied! Toggle word wrap Toggle overflow 指定主题名称的格式与

oc describe命令的格式在第 1 步中返回,例如inventory-connector-db2.inventory.addresses。对于主题中的每个事件,命令会返回类似以下输出的信息:

例 3.5. Debezium 更改事件的内容

{"schema":{"type":"struct","fields":[{"type":"int32","optional":false,"field":"product_id"}],"optional":false,"name":"inventory-connector-db2.inventory.products_on_hand.Key"},"payload":{"product_id":101}} {"schema":{"type":"struct","fields":[{"type":"struct","fields":[{"type":"int32","optional":false,"field":"product_id"},{"type":"int32","optional":false,"field":"quantity"}],"optional":true,"name":"inventory-connector-db2.inventory.products_on_hand.Value","field":"before"},{"type":"struct","fields":[{"type":"int32","optional":false,"field":"product_id"},{"type":"int32","optional":false,"field":"quantity"}],"optional":true,"name":"inventory-connector-db2.inventory.products_on_hand.Value","field":"after"},{"type":"struct","fields":[{"type":"string","optional":false,"field":"version"},{"type":"string","optional":false,"field":"connector"},{"type":"string","optional":false,"field":"name"},{"type":"int64","optional":false,"field":"ts_ms"},{"type":"string","optional":true,"name":"io.debezium.data.Enum","version":1,"parameters":{"allowed":"true,last,false"},"default":"false","field":"snapshot"},{"type":"string","optional":false,"field":"db"},{"type":"string","optional":true,"field":"sequence"},{"type":"string","optional":true,"field":"table"},{"type":"int64","optional":false,"field":"server_id"},{"type":"string","optional":true,"field":"gtid"},{"type":"string","optional":false,"field":"file"},{"type":"int64","optional":false,"field":"pos"},{"type":"int32","optional":false,"field":"row"},{"type":"int64","optional":true,"field":"thread"},{"type":"string","optional":true,"field":"query"}],"optional":false,"name":"io.debezium.connector.db2.Source","field":"source"},{"type":"string","optional":false,"field":"op"},{"type":"int64","optional":true,"field":"ts_ms"},{"type":"struct","fields":[{"type":"string","optional":false,"field":"id"},{"type":"int64","optional":false,"field":"total_order"},{"type":"int64","optional":false,"field":"data_collection_order"}],"optional":true,"field":"transaction"}],"optional":false,"name":"inventory-connector-db2.inventory.products_on_hand.Envelope"},"payload":{"before":null,"after":{"product_id":101,"quantity":3},"source":{"version":"2.1.4.Final-redhat-00001","connector":"db2","name":"inventory-connector-db2","ts_ms":1638985247805,"snapshot":"true","db":"inventory","sequence":null,"table":"products_on_hand","server_id":0,"gtid":null,"file":"db2-bin.000003","pos":156,"row":0,"thread":null,"query":null},"op":"r","ts_ms":1638985247805,"transaction":null}}{"schema":{"type":"struct","fields":[{"type":"int32","optional":false,"field":"product_id"}],"optional":false,"name":"inventory-connector-db2.inventory.products_on_hand.Key"},"payload":{"product_id":101}} {"schema":{"type":"struct","fields":[{"type":"struct","fields":[{"type":"int32","optional":false,"field":"product_id"},{"type":"int32","optional":false,"field":"quantity"}],"optional":true,"name":"inventory-connector-db2.inventory.products_on_hand.Value","field":"before"},{"type":"struct","fields":[{"type":"int32","optional":false,"field":"product_id"},{"type":"int32","optional":false,"field":"quantity"}],"optional":true,"name":"inventory-connector-db2.inventory.products_on_hand.Value","field":"after"},{"type":"struct","fields":[{"type":"string","optional":false,"field":"version"},{"type":"string","optional":false,"field":"connector"},{"type":"string","optional":false,"field":"name"},{"type":"int64","optional":false,"field":"ts_ms"},{"type":"string","optional":true,"name":"io.debezium.data.Enum","version":1,"parameters":{"allowed":"true,last,false"},"default":"false","field":"snapshot"},{"type":"string","optional":false,"field":"db"},{"type":"string","optional":true,"field":"sequence"},{"type":"string","optional":true,"field":"table"},{"type":"int64","optional":false,"field":"server_id"},{"type":"string","optional":true,"field":"gtid"},{"type":"string","optional":false,"field":"file"},{"type":"int64","optional":false,"field":"pos"},{"type":"int32","optional":false,"field":"row"},{"type":"int64","optional":true,"field":"thread"},{"type":"string","optional":true,"field":"query"}],"optional":false,"name":"io.debezium.connector.db2.Source","field":"source"},{"type":"string","optional":false,"field":"op"},{"type":"int64","optional":true,"field":"ts_ms"},{"type":"struct","fields":[{"type":"string","optional":false,"field":"id"},{"type":"int64","optional":false,"field":"total_order"},{"type":"int64","optional":false,"field":"data_collection_order"}],"optional":true,"field":"transaction"}],"optional":false,"name":"inventory-connector-db2.inventory.products_on_hand.Envelope"},"payload":{"before":null,"after":{"product_id":101,"quantity":3},"source":{"version":"2.1.4.Final-redhat-00001","connector":"db2","name":"inventory-connector-db2","ts_ms":1638985247805,"snapshot":"true","db":"inventory","sequence":null,"table":"products_on_hand","server_id":0,"gtid":null,"file":"db2-bin.000003","pos":156,"row":0,"thread":null,"query":null},"op":"r","ts_ms":1638985247805,"transaction":null}}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在上例中,

有效负载值显示连接器快照从表inventory.products_on_hand中生成一个读取("op" ="r")事件。product_id记录的"before"状态为null,这表示记录没有之前的值。"after"状态对于product_id为101的项目的quantity显示为3。

3.6.6. Debezium Db2 连接器配置属性的描述

Debezium Db2 连接器有许多配置属性,您可以使用它们来实现应用程序的正确连接器行为。许多属性具有默认值。有关属性的信息按如下方式进行组织:

- 所需的配置属性

- 高级配置属性

数据库架构历史记录配置属性,用于控制 Debezium 如何处理从数据库架构历史记录主题读取的事件。

- 控制 数据库驱动程序行为的直通数据库驱动程序属性。

所需的 Debezium Db2 连接器配置属性

除非默认值可用 , 否则需要以下配置属性。

| 属性 | 默认 | 描述 |

|---|---|---|

| 没有默认值 | 连接器的唯一名称。尝试再次使用相同的名称注册将失败。所有 Kafka Connect 连接器都需要此属性。 | |

| 没有默认值 |

连接器的 Java 类的名称。对于 Db2 连接器,始终使用 | |

|

| 应该为此连接器创建的最大任务数量。Db2 连接器始终使用单个任务,因此不要使用这个值,因此始终可以接受默认值。 | |

| 没有默认值 | Db2 数据库服务器的 IP 地址或主机名。 | |

|

| Db2 数据库服务器的整数端口号。 | |

| 没有默认值 | 用于连接到 Db2 数据库服务器的 Db2 数据库用户的名称。 | |

| 没有默认值 | 连接到 Db2 数据库服务器时要使用的密码。 | |

| 没有默认值 | 从中流传输更改的 Db2 数据库的名称 | |

| 没有默认值 |

为特定的 Db2 数据库服务器提供命名空间前缀,用于托管 Debezium 正在捕获更改的数据库。主题前缀名称中只能使用字母数字字符、连字符、句点和下划线。主题前缀应该在所有其他连接器中唯一,因为此主题前缀用于接收这个连接器记录的所有 Kafka 主题。 警告 不要更改此属性的值。如果您更改了 name 值,重启后,而不是继续向原始主题发出事件,连接器会将后续事件发送到名称基于新值的主题。连接器也无法恢复其数据库架构历史记录主题。 | |

| 没有默认值 |

可选的、以逗号分隔的正则表达式列表,与您希望连接器捕获的表的完全限定表标识符匹配。当设置此属性时,连接器只从指定的表中捕获更改。每个标识符的格式都是 schemaName。tableName。默认情况下,连接器捕获每个非系统表中的更改。

要匹配表的名称,Debebe 应用您指定的正则表达式。也就是说,指定的表达式与表的全名称字符串匹配,它与表名称中可能存在的子字符串不匹配。 | |

| 没有默认值 |

可选的、以逗号分隔的正则表达式列表,与您不想连接器捕获的表的完全限定表标识符匹配。连接器捕获未包含在 exclude 列表中的每个非系统表中的更改。每个标识符的格式都是 schemaName。tableName。

要匹配表的名称,Debebe 应用您指定的正则表达式。也就是说,指定的表达式与表的全名称字符串匹配,它与表名称中可能存在的子字符串不匹配。 | |

| 空字符串 |

可选的、以逗号分隔的正则表达式列表,与更改事件记录值中包含的列的完全限定名称匹配。列的完全限定域名格式为 schemaName。tableName.columnName。

要匹配列的名称,Debebe 应用您指定的正则表达式。也就是说,指定的表达式与列的整个名称字符串匹配,它与列名称中可能存在的子字符串不匹配。如果您在配置中包含此属性,不要设置 | |

| 空字符串 |

可选的、以逗号分隔的正则表达式列表,与列的完全限定名称匹配,以便从更改事件值中排除。列的完全限定域名格式为 schemaName。tableName.columnName。

要匹配列的名称,Debebe 应用您指定的正则表达式。也就是说,指定的表达式与列的整个名称字符串匹配,它与列名称中可能存在的子字符串不匹配。事件键中始终包含主键列,即使它们不包括在值中。如果您在配置中包含此属性,请不要设置 | |

| 不适用 |

一个可选的、以逗号分隔的正则表达式列表,与基于字符的列的完全限定名称匹配。列的完全限定域名格式为 schemaName。tableName.columnName。

一个 pseudonym,它包括了通过应用指定的 hashAlgorithm 和 salt 的结果的哈希值。根据使用的 hash 功能,会维护引用完整性,而列值则替换为伪nyms。支持的哈希功能在 Java Cryptography 架构标准算法名称文档中的 MessageDigest 部分 进行了描述。 column.mask.hash.SHA-256.with.salt.CzQMA0cB5K = inventory.orders.customerName, inventory.shipment.customerName

如有必要,伪的nym 会自动缩短到列的长度。连接器配置可以包含多个指定不同哈希算法和 salt 的属性。 | |

|

|

时间、日期和时间戳可以通过不同类型的精度 | |

|

|

控制 删除 事件是否随后是 tombstone 事件。 | |

|

| 指定连接器是否应该将数据库模式中的更改发布到与数据库服务器 ID 的名称相同的 Kafka 主题的布尔值。每个架构更改都会使用一个键进行记录,其中包含数据库名称和一个 JSON 结构,用于描述 schema 更新。这独立于连接器内部记录数据库架构历史记录。 | |

| 不适用 |

一个可选的、以逗号分隔的正则表达式列表,与基于字符的列的完全限定名称匹配。如果您要在一组列中超过属性名称中指定的字符数时,设置此属性。将 列的完全限定域名会观察以下格式: schemaName.tableName.columnName。要匹配列的名称,Debebe 应用您指定的正则表达式。也就是说,指定的表达式与列的整个名称字符串匹配;表达式不匹配列名称中可能存在的子字符串。 您可以在单个配置中指定多个长度不同的属性。 | |

| 不适用 |

一个可选的、以逗号分隔的正则表达式列表,与基于字符的列的完全限定名称匹配。如果您希望连接器屏蔽一组列的值,例如,如果它们包含敏感数据,则设置此属性。将

列的完全限定域名会观察以下格式: schemaName.tableName.columnName。 您可以在单个配置中指定多个长度不同的属性。 | |

| 不适用 | 可选的、以逗号分隔的正则表达式列表,它与您希望连接器发送代表列元数据的完全限定名称匹配。当设置此属性时,连接器会将以下字段添加到事件记录的架构中:

这些参数分别传播列的原始类型和长度(用于变量带宽类型)。

列的完全限定域名会观察以下格式之一: databaseName.tableName.columnName, 或 databaseName.schemaName.tableName.columnName. | |

| 不适用 | 可选的、以逗号分隔的正则表达式列表,用于指定为数据库列定义的数据类型的完全限定名称。当设置此属性时,对于具有匹配数据类型的列,连接器会发出事件记录,该记录在 schema 中包含以下额外字段:

这些参数分别传播列的原始类型和长度(用于变量带宽类型)。

列的完全限定域名会观察以下格式之一: databaseName.tableName.typeName, 或 databaseName.schemaName.tableName.typeName. 有关特定于 Db2 的数据类型名称的列表,请查看 Db2 数据类型映射。 | |

| 空字符串 | 指定连接器用来组成自定义消息键的表达式列表,以更改它发布到指定表的 Kafka 主题的事件记录。

默认情况下,Debezium 使用表的主键列作为它发出的记录的消息键。对于缺少主密钥的表,或者指定缺少主密钥的表的密钥,您可以根据一个或多个列配置自定义消息密钥。

属性可以列出多个表的条目。使用分号分隔列表中不同表的条目。 | |

| none |

指定如何调整架构名称,以便与连接器使用的消息转换器兼容。可能的设置:

|

高级连接器配置属性

以下 高级配置 属性具有在大多数情况下工作的默认值,因此很少需要在连接器配置中指定。

| 属性 | 默认 | 描述 |

|---|---|---|

| 没有默认值 |

枚举连接器可以使用 的自定义转换器 实例的符号名称的逗号分隔列表。例如,

您必须设置

对于您为连接器配置的每个转换器,还必须添加一个

例如, isbn.type: io.debezium.test.IsbnConverter

如果要进一步控制配置的转换器的行为,您可以添加一个或多个配置参数将值传递给转换器。要将任何其他配置参数与转换器关联,请将参数名称与转换器的符号链接名称添加前缀。 isbn.schema.name: io.debezium.db2.type.Isbn | |

|

|

指定在连接器启动 | |

|

|

在快照中,控制事务隔离级别以及连接器锁定处于捕获模式的表的时长。可能的值有: | |

|

|

指定连接器如何处理事件处理异常。可能的值有: | |

|

| 正整数值,用于指定连接器在处理批处理事件前应该等待出现新更改事件的毫秒数。默认值为 500 毫秒,或 0.5 秒。 | |

|

| 正整数值,用于指定连接器进程每个批处理的最大大小。 | |

|

|

正整数值,用于指定阻塞队列可以保存的最大记录数。当 Debezium 从数据库读取事件时,它会将事件放置在阻塞队列中,然后再将它们写入 Kafka。当连接器将消息写入 Kafka 或 Kafka 不可用时,阻塞队列可以提供从数据库读取更改事件的后端。当连接器定期记录偏移时,队列中保存的事件会被忽略。始终将 | |

|

|

较长的整数值,指定块队列的最大卷(以字节为单位)。默认情况下,不会为阻塞队列指定卷限制。要指定队列可以使用的字节数,请将此属性设置为正长值。 | |

|

|

控制连接器将心跳信息发送到 Kafka 主题的频率。默认行为是连接器不会发送心跳信息。 | |

| 没有默认值 | 连接器在连接器启动时应等待的时间(毫秒)。如果您要在集群中启动多个连接器,此属性对于避免快照中断非常有用,这可能会导致连接器重新平衡。 | |

|

|

可选的、以逗号分隔的正则表达式列表,与表的完全限定名称(< 要匹配表的名称,Debebe 应用您指定的正则表达式。也就是说,指定的表达式与表的整个名称字符串匹配,它与表名称中可能存在的子字符串不匹配。 | |

|

| 在快照中,连接器以行批处理形式读取表内容。此属性指定批处理中的最大行数。 | |

|

|

正整数值,用于指定在执行快照时等待获取表锁定的最长时间(以毫秒为单位)。如果连接器无法在这个间隔中获取表锁定,快照会失败。连接器如何提供快照 提供详情。其他可能的设置是: | |

| 没有默认值 | 指定要包含在快照中的表行。如果您希望快照仅在表中包括行的子集,请使用此属性。此属性仅影响快照。它不适用于连接器从日志中读取的事件。

属性包含一个以逗号分隔的表名称列表,格式为 <

在包含 soft-delete 列 "snapshot.select.statement.overrides": "customer.orders", "snapshot.select.statement.overrides.customer.orders": "SELECT * FROM [customers].[orders] WHERE delete_flag = 0 ORDER BY id DESC"

在生成的快照中,连接器仅包含 | |

|

如果连接器配置将

如果没有,则为 | 指明是否清理字段名称以遵循 Avro 命名要求。 | |

|

|

确定连接器是否生成带有事务边界的事件,并使用事务元数据增强更改事件。如果您希望连接器进行此操作,请指定 | |

|

|

以逗号分隔的操作类型列表,这些类型将在流期间跳过。操作包括: | |

| 没有默认值 |

用于向连接器发送信号的数据收集的完全限定名称。https://access.redhat.com/documentation/zh-cn/red_hat_build_of_debezium/2.1.4/html-single/debezium_user_guide/index#debezium-signaling-enabling-signaling使用以下格式指定集合名称: | |

|

| 连接器在增量快照块期间获取并读取内存的最大行数。增加块大小可提高效率,因为快照会运行更大的快照查询。但是,较大的块大小还需要更多内存来缓冲快照数据。将块大小调整为在您的环境中提供最佳性能的值。 | |

|

|

应该用来决定数据更改的主题名称、模式更改、事务、心跳事件等的 TopicNamingStrategy 类的名称,默认为 | |

|

|

指定主题名称的分隔符,默认为 | |

|

| 用于在绑定并发哈希映射中保存主题名称的大小。此缓存有助于确定与给定数据收集对应的主题名称。 | |

|

|

控制连接器向发送心跳消息的主题名称。主题名称具有此模式: | |

|

|

控制连接器向发送事务元数据消息的主题名称。主题名称具有此模式: |

Debezium 连接器数据库模式历史记录配置属性

Debezium 提供了一组 schema.history.internal114 属性,用于控制连接器如何与 schema 历史记录主题交互。

下表描述了用于配置 Debezium 连接器的 schema.history.internal 属性。

| 属性 | 默认 | 描述 |

|---|---|---|

| 没有默认值 | 连接器存储数据库架构历史记录的 Kafka 主题的完整名称。 | |

| 没有默认值 | 连接器用来建立到 Kafka 集群的初始连接的主机/端口对列表。此连接用于检索之前由连接器存储的数据库架构历史记录,并编写从源数据库读取的每个 DDL 语句。每个对都应该指向 Kafka Connect 进程使用的相同 Kafka 集群。 | |

|

| 整数值,用于指定连接器在轮询保留数据时应该等待的最大毫秒数。默认值为 100ms。 | |

|

| 指定连接器在使用 Kafka admin 客户端获取集群信息时应等待的最大毫秒数。 | |

|

| 指定连接器在使用 Kafka admin 客户端创建 kafka 历史记录主题时应等待的最大毫秒数。 | |

|

|

连接器在连接器恢复失败前读取保留历史记录数据的次数上限。在收到数据后等待的最长时间为 | |

|

|

指定连接器是否应该忽略不正确的或未知数据库语句或停止处理等布尔值,以便人可以解决这个问题。安全默认值为 | |

|

|

指定连接器是否应该记录所有 DDL 语句的布尔值

安全默认值为 |

直通数据库模式历史记录属性,用于配置制作者和消费者客户端

Debezium 依赖于 Kafka producer 将模式更改写入数据库架构历史记录主题。同样,它依赖于 Kafka 使用者在连接器启动时从数据库 schema 历史记录主题中读取。您可以通过将值分配给以 schema.history.internal.consumer 前缀开头的一组直通配置属性来定义 Kafka producer 和 消费者 客户端的配置。直通制作者和消费者数据库模式历史记录属性控制一系列行为,如这些客户端如何与 Kafka 代理安全连接,如下例所示:

Debezium 在将属性传递给 Kafka 客户端之前,从属性名称中分离前缀。

如需有关 Kafka producer 配置属性和 Kafka 使用者配置属性的更多详情,请参阅 Kafka 文档。

Debezium 连接器传递数据库驱动程序配置属性

Debezium 连接器为数据库驱动程序的透传配置提供。直通数据库属性以前缀 驱动程序 开头。例如,连接器将 driver.foobar=false 等属性传递给 JDBC URL。

与 数据库架构历史记录客户端的直通属性 一样,Debebe 会将属性中的前缀从属性分离,然后再将它们传递给数据库驱动程序。

3.7. 监控 Debezium Db2 连接器性能

Debezium Db2 连接器除了对 Apache ZooKeeper、Apache Kafka 和 Kafka Connect 提供的 JMX 指标的内置支持外,还提供三种类型的指标。

Debezium 监控文档 提供了有关如何使用 JMX 公开这些指标的详细信息。

3.7.1. 在 Db2 数据库的快照期间监控 Debezium

MBean 是 debezium.db2:type=connector-metrics,context=snapshot,server= <db2.server.name>。

除非快照操作处于活跃状态,否则快照指标不会被公开,或者快照自上次连接器启动后发生。

下表列出了可用的 shapshot 指标。

| 属性 | 类型 | 描述 |

|---|---|---|

|

| 连接器读取的最后一个快照事件。 | |

|

| 连接器读取和处理最新事件以来的毫秒数。 | |

|

| 此连接器从上次启动或重置后看到的事件总数。 | |

|

| 由连接器中配置的 include/exclude 列表过滤规则过滤的事件数。 | |

|

| 连接器捕获的表列表。 | |

|

| 用于在快照和主 Kafka Connect 循环之间传递事件的队列长度。 | |

|

| 用于在快照和主 Kafka Connect 循环之间传递事件的队列的空闲容量。 | |

|

| 包括在快照中的表的总数。 | |

|

| 快照要复制的表数。 | |

|

| 快照是否启动。 | |

|

| 快照是否暂停。 | |

|

| 快照是否中止。 | |

|

| 快照是否完成。 | |

|

| 快照目前花费的秒数,即使未完成也是如此。还包括快照暂停时的时间。 | |

|

| 快照暂停的秒数。如果快照暂停多次,则暂停的时间会增加。 | |

|

| 包含快照中每个表扫描的行数的映射。表在处理期间逐步添加到映射中。更新每个 10,000 行扫描,并在完成表后更新。 | |

|

|

队列的最大缓冲区(以字节为单位)。如果 | |

|

| 队列中记录的当前卷(以字节为单位)。 |

在执行增量快照时,连接器还提供以下额外快照指标:

3.7.2. 监控 Debezium Db2 连接器记录流

MBean 是 debezium.db2:type=connector-metrics,context=streaming,server= <db2.server.name>。

下表列出了可用的流指标。

| 属性 | 类型 | 描述 |

|---|---|---|

|

| 连接器读取的最后一个流事件。 | |

|

| 连接器读取和处理最新事件以来的毫秒数。 | |

|

| 此连接器自上次开始或指标重置以来看到的事件总数。 | |

|

| 此连接器自上次开始或指标重置以来看到的创建事件总数。 | |

|

| 此连接器自上次开始或指标重置以来看到的更新事件总数。 | |

|

| 此连接器自上次开始或指标重置以来看到的删除事件总数。 | |

|

| 由连接器中配置的 include/exclude 列表过滤规则过滤的事件数。 | |

|

| 连接器捕获的表列表。 | |

|

| 用于在流和主 Kafka Connect 循环之间传递事件的队列长度。 | |

|

| 用于在流和主 Kafka Connect 循环之间传递事件的队列的空闲容量。 | |

|

| 表示连接器当前是否连接到数据库服务器的标记。 | |

|

| 最后一次更改事件时间戳和连接器处理之间毫秒的数量。该值将限制运行数据库服务器和连接器的机器上时钟之间的差别。 | |

|

| 已提交的已处理的事务数量。 | |

|

| 最后一次接收的事件的协调。 | |

|

| 最后一次处理的事务的事务标识符。 | |

|

|

队列的最大缓冲区(以字节为单位)。如果 | |

|

| 队列中记录的当前卷(以字节为单位)。 |

3.7.3. 监控 Debezium Db2 连接器模式历史记录

MBean 是 debezium.db2:type=connector-metrics,context=schema-history,server= <db2.server.name>。

下表列出了可用的模式历史记录指标。

| 属性 | 类型 | 描述 |

|---|---|---|

|

|

| |

|

| 恢复开始的时间(以 epoch 秒为单位)。 | |

|

| 恢复阶段读取的更改数量。 | |

|

| 恢复和运行时应用的架构更改总数。 | |

|

| 从历史记录存储中恢复自上次更改以来的毫秒数。 | |

|

| 从上次更改被应用后经过的毫秒数。 | |

|

| 从历史记录存储中恢复最后一次更改的字符串表示。 | |

|

| 最后一次应用的更改的字符串表示。 |

3.8. 管理 Debezium Db2 连接器

部署 Debezium Db2 连接器后,请使用 Debezium 管理 UDFs 来使用 SQL 命令控制 Db2 复制(ASN)。有些 UDF 期望一个返回值,在这种情况下,您可以使用 SQL VALUE 语句来调用它们。对于其他 UDF,请使用 SQL CALL 语句。

| 任务 | 命令和备注 |

|---|---|

|

| |

|

| |

|

| |

|

| |

|

| |

|

|

3.9. 更新 Debezium 连接器捕获模式的 Db2 表的模式

虽然 Debezium Db2 连接器可以捕获架构更改,但为了更新架构,您必须与数据库管理员合作,以确保连接器继续生成更改事件。这通过 Db2 实施复制的方式是必需的。

对于捕获模式中的每个表,Db2 的复制功能会创建一个 change-data 表,其中包含该源表的所有更改。但是,change-data 表模式是静态的。如果您在捕获模式下为表更新模式,还必须更新其对应 change-data 表的 schema。Debezium Db2 连接器无法执行此操作。具有升级权限的数据库管理员必须为处于捕获模式的表更新模式。

在在同一表中有新的架构更新前,完全执行架构更新过程非常重要。因此,建议是在单个批处理中执行所有 DDL,因此架构更新过程仅一次完成。

通常有两个更新表模式的步骤:

每种方法都有优势和缺点。

3.9.1. 为 Debezium Db2 连接器执行离线 schema 更新

在执行离线架构更新前,您将停止 Debezium Db2 连接器。虽然这是更安全的模式更新流程,但可能不适用于具有高可用性要求的应用程序。

先决条件

- 处于捕获模式的一个或多个表需要 schema 更新。

流程

- 暂停更新数据库的应用。

- 等待 Debezium 连接器流传输所有未流更改事件记录。

- 停止 Debezium 连接器。

- 将所有更改应用到源表模式。

-

在 ASN 注册表中,将更新的模式标记为

INACTIVE。 - 重新初始化 ASN 捕获服务。

- 通过运行 Debezium UDF 从捕获模式中删除表,从捕获模式中删除带有旧模式的源表。

- 使用新模式添加源表以捕获模式,方法是运行 Debezium UDF 将表添加到捕获模式。

-

在 ASN 注册表中,将更新的源表标记为

ACTIVE。 - 重新初始化 ASN 捕获服务。

- 恢复更新数据库的应用程序。

- 重启 Debezium 连接器。

3.9.2. 为 Debezium Db2 连接器执行在线 schema 更新

在线 schema 更新不会导致应用程序和数据处理的停机时间。也就是说,在执行在线架构更新前,您不会停止 Debezium Db2 连接器。另外,在线架构更新过程比离线架构更新的步骤要简单。

但是,当表处于捕获模式时,在更改列名称后,Db2 复制功能将继续使用旧列名称。新列名称不会出现在 Debezium 更改事件中。您必须重启连接器才能在更改事件中看到新列名称。

先决条件

- 处于捕获模式的一个或多个表需要 schema 更新。

在表末尾添加列的步骤

- 锁定您要更改其模式的源表。

-

在 ASN 注册表中,将锁定的表标记为

INACTIVE。 - 重新初始化 ASN 捕获服务。

- 将所有更改应用到源表的 schema。

- 对相应 change-data 表的 schema 应用所有更改。

-

在 ASN 注册表中,将源表标记为

ACTIVE。 - 重新初始化 ASN 捕获服务。

- 可选。重启连接器以查看更改事件中的更新列名称。

在表的中间添加列时的流程

- 锁定要更改的源表。

-

在 ASN 注册表中,将锁定的表标记为

INACTIVE。 - 重新初始化 ASN 捕获服务。

对于要更改的每个源表,请执行以下操作:

- 在源表中导出数据。

- 截断源表。

- 更改源表并添加列。

- 将导出的数据加载到更改的源表中。

- 在源表的对应 change-data 表中导出数据。

- 截断 change-data 表。

- 更改 change-data 表并添加列。

- 将导出的数据加载到更改的 change-data 表中。

-

在 ASN 注册表中,将表标记为

INACTIVE。这会将旧的 change-data 表标记为 inactive,这样允许其中的数据保留,但不再更新它们。 - 重新初始化 ASN 捕获服务。

- 可选。重启连接器以查看更改事件中的更新列名称。

第 4 章 MongoDB 的 Debezium 连接器

Debezium 的 MongoDB 连接器跟踪 MongoDB 副本集或 MongoDB 分片集群,用于记录数据库和集合,在 Kafka 主题中记录这些更改。连接器自动处理分片集群中分片的添加或删除,更改每个副本集的成员资格、每个副本集中的选举,以及等待通信问题解析。

有关与此连接器兼容的 MongoDB 版本的详情,请参考 Debezium 支持的配置页面。

使用 Debezium MongoDB 连接器的信息和流程进行组织,如下所示:

4.1. Debezium MongoDB 连接器概述

MongoDB 的复制机制提供冗余和高可用性,这是在生产环境中运行 MongoDB 的首选方法。MongoDB 连接器捕获副本集或分片集群中的更改。

MongoDB 副本集 由一组服务器组成,所有服务器都有相同数据的副本,并且复制可确保客户端对副本集 的主 文档所做的所有更改都会正确应用到其他副本集的服务器,称为 第二个信息。MongoDB 复制的工作原理是:主记录其 oplog (或操作日志),第二方都会读取主的 oplog,并应用所有操作对自己的文档。当将新的服务器添加到副本集时,该服务器首先在主服务器上执行所有数据库和集合 的快照,然后读取主的 oplog 以应用自快照开始的所有更改。当该服务器捕获到主 oplog 的尾部时,该服务器就成为次要(并可处理查询)。

4.1.1. MongoDB 连接器如何使用更改流捕获事件记录的描述

虽然 Debezium MongoDB 连接器没有成为副本集的一部分,但它使用类似的复制机制来获取 oplog 数据。主要区别在于连接器不会直接读取 oplog。相反,它会将 oplog 数据的捕获和解码委派给 MongoDB 更改流 功能。通过更改流,MongoDB 服务器会公开集合中作为事件流所做的更改。Debezium 连接器监控流,然后提供下游更改。连接器第一次检测到副本集时,它会检查 oplog 以获取最后记录的事务,然后执行主数据库和集合的快照。连接器完成复制数据后,它会从之前读取的 oplog 位置创建一个更改流。

随着 MongoDB 连接器处理更改,它会定期记录事件源自在 oplog 流中的位置。当连接器停止时,它会记录它处理的最后一个 oplog 流位置,以便在重启后它可以从该位置恢复流。换句话说,可以停止、升级或维护连接器,并在稍后重启一些时间,并且始终在不丢失单个事件的情况下完全关闭它。当然,MongoDB oplogs 通常上限为最大大小,因此如果长时间停止连接器,则 oplog 中的操作可能会在连接器读取前清除。在这种情况下,重启后连接器检测到缺少的 oplog 操作,执行快照,然后进行流更改。

MongoDB 连接器还对副本集的成员资格和领导、添加或删除分片集群中的分片以及可能导致通信失败的网络问题有很大的修改。连接器始终使用副本集的主节点来流更改,因此当副本集强制和不同的节点变为主节点时,连接器将立即停止流更改,连接到新的主节点,并使用新的主节点开始流更改。同样,如果连接器无法与副本集主通信,它将尝试重新连接(使用 exponential backoff,以便不可能造成网络或副本集)。重新建立连接后,连接器将继续从捕获的最后一个事件更改。这样,连接器会动态调整副本设置成员资格的变化,并自动处理通信中断。

4.2. Debezium MongoDB 连接器的工作方式

有关连接器支持的 MongoDB 拓扑概述,用于规划应用程序。

当配置和部署 MongoDB 连接器时,它会首先通过连接到 seed 地址的 MongoDB 服务器,并确定每个可用副本集的详情。由于每个副本集都有自己的独立的 oplog,因此连接器会尝试为每个副本集使用单独的任务。连接器可以限制将使用的最大任务数量,如果没有足够的任务可用,则连接器会将多个副本集分配给每个任务,但任务仍会为每个副本集使用单独的线程。

在针对分片集群运行连接器时,请使用大于副本集数的 tasks.max 值。这将允许连接器为每个副本集创建一个任务,并允许 Kafka Connect 协调、分发和管理所有可用 worker 进程中的任务。

以下主题提供有关 Debezium MongoDB 连接器如何工作的详细信息:

- 第 4.2.1 节 “Debezium 连接器支持的 MongoDB 拓扑”

- 第 4.2.2 节 “Debezium MongoDB 连接器如何为副本集和分片集群使用逻辑名称”

- 第 4.2.3 节 “Debezium MongoDB 连接器如何执行快照”

- 第 4.2.4 节 “Debezium MongoDB 连接器流更改事件记录”

- 第 4.2.6 节 “接收 Debezium MongoDB 更改事件记录的 Kafka 主题默认名称”

- 第 4.2.7 节 “Debezium MongoDB 连接器的事件键控制主题分区的方式”

- 第 4.2.8 节 “Debezium MongoDB 连接器生成的事件代表事务边界”

4.2.1. Debezium 连接器支持的 MongoDB 拓扑

MongoDB 连接器支持以下 MongoDB 拓扑:

- MongoDB 副本集

Debezium MongoDB 连接器可以从单个 MongoDB 副本集 捕获更改。生产环境副本集 至少需要三个成员。

要将 MongoDB 连接器与副本集一起使用,请使用连接器的

mongodb.hosts属性提供一个或多个副本集服务器的地址作为 seed addresses。连接器将使用这些 seeds 连接到副本集,然后在连接后从副本集获取完整的成员集合,以及哪些成员是主成员。连接器将启动一个任务来连接到主设备并从主 oplog 中捕获更改。当副本集选择新主主时,任务将自动切换到新的主设备。注意当 MongoDB 由代理(如 OS X 或 Windows 上的 Docker)开头时,当客户端连接到副本集并发现成员时,MongoDB 客户端将排除代理作为有效成员,并将尝试并无法直接连接到成员,而不是通过代理进行连接。

在这种情况下,将连接器的可选

mongodb.members.auto.discover配置属性设置为false,以指示连接器强制识别身份发现,而是使用第一个 seed 地址(通过mongodb.hosts属性指定)作为主节点。这可能会正常工作,但仍在选举发生时导致问题。

- MongoDB 分片集群

MongoDB 分片集群 包括:

- 一个或多个 分片,各自部署为副本集;

- 用作 集群配置服务器的独立副本集

客户端需要连接到的一个或多个 routers (也称为

mongos)。它们会将请求路由到相关的分片。要将 MongoDB 连接器与分片集群搭配使用,请使用 配置服务器副本集的主机地址配置 连接器。当连接器连接到此副本集时,它会发现它充当分片集群的配置服务器,发现有关集群中用作分片的每个副本集的信息,然后启动一个单独的任务来捕获每个副本集中的更改。如果向集群或现有分片添加了新的分片,连接器将相应地调整其任务。

- MongoDB 独立服务器

- MongoDB 连接器无法监控独立 MongoDB 服务器的更改,因为单机服务器没有 oplog。如果单机服务器转换为一个成员设置的副本集,则连接器将可以正常工作。

MongoDB 不建议在生产环境中运行独立服务器。如需更多信息,请参阅 MongoDB 文档。

4.2.2. Debezium MongoDB 连接器如何为副本集和分片集群使用逻辑名称

连接器配置属性 topic.prefix 充当 MongoDB 副本集或分片集群的逻辑名称。连接器以多种方式使用逻辑名称: 作为所有主题名称的前缀,在记录每个副本集的更改流位置时作为唯一标识符。

您应该为每个 MongoDB 连接器指定一个有意义的逻辑名称,它有意义的描述源 MongoDB 系统。我们建议逻辑名称以字母或下划线字符开头,剩余字符为字母数字字符或下划线。

4.2.3. Debezium MongoDB 连接器如何执行快照

当任务使用副本集启动时,它会使用连接器的逻辑名称和副本集名称来查找偏移,该 偏移 描述了连接器之前停止读取更改的位置。如果可以找到偏移,并且它仍然存在于 oplog 中,则任务会立即进行 流更改,从记录的偏移位置开始。

但是,如果没有找到偏移,或者 oplog 不再包含该位置,则任务必须首先通过 执行快照 来获取副本集内容的当前状态。这个过程首先记录 oplog 的当前位置,并记录为偏移量(以及表示已启动快照的标记)。然后,该任务将继续复制每个集合,尽可能生成线程(最多为 snapshot.max.threads 配置属性的值)来并行执行这一工作。连接器将为每个文档记录一个单独的 读取事件,并且读取事件将包含对象的标识符、对象的完整状态,以及找到对象的 MongoDB 副本集 的源 信息。源信息还包括一个标记,表示事件是在快照期间生成的。

此快照将继续,直到复制了与连接器过滤器匹配的所有集合。如果在任务的快照完成前停止连接器,在重启连接器后再次开始快照。

尝试避免在连接器执行任何副本集的快照时避免任务重新分配和重新配置。连接器会生成日志消息来报告快照的进度。要提供最大的控制,请为每个连接器运行单独的 Kafka Connect 集群。

4.2.3.1. 临时快照

临时快照是 Debezium MongoDB 连接器的技术预览功能。技术预览功能不被红帽产品服务级别协议(SLA)支持,且可能无法完成。因此,红帽不推荐在生产环境中实施任何技术预览功能。此技术预览功能为您提供对即将推出的产品创新的早期访问,允许您在开发过程中测试并提供反馈。如需有关支持范围的更多信息,请参阅 技术预览功能支持范围。

默认情况下,连接器仅在首次启动后运行初始快照操作。在正常情况下,遵循这个初始快照,连接器不会重复快照过程。连接器捕获的任何将来更改事件数据都仅通过流传输过程。

然而,在某些情况下,连接器在初始快照期间获取的数据可能会变得过时、丢失或不完整。为了提供总结集合数据的机制,Debezium 包含一个执行临时快照的选项。数据库中的以下更改可能是执行临时快照:

- 连接器配置会被修改来捕获不同的集合集。

- Kafka 主题已删除,必须重建。

- 由于配置错误或某些其他问题导致数据损坏。

您可以通过启动所谓的 临时命令快照,为之前捕获的快照重新运行快照。临时快照需要使用 信号集合。您可以通过向 Debezium 信号集合发送信号请求来启动临时快照。

当您启动现有集合的临时快照时,连接器会将内容附加到集合已存在的主题中。如果删除了之前存在的主题,如果启用自动主题创建,Debezium 可以自动创建主题。https://access.redhat.com/documentation/zh-cn/red_hat_build_of_debezium/2.1.4/html-single/debezium_user_guide/index#customization-of-kafka-connect-automatic-topic-creation

临时快照信号指定要包含在快照中的集合。快照可以捕获数据库的整个内容,或者只捕获数据库中的集合子集。另外,快照也可以捕获数据库中集合内容的子集。

您可以通过向信号集合发送 execute-snapshot 消息来指定要捕获的集合。将 execute-snapshot 信号的类型设置为增量,并提供快照中包含的集合名称,如下表所述:

| 字段 | 默认 | 值 |

|---|---|---|

|

|

|

指定您要运行的快照类型。 |

|

| 不适用 |

包含与要快照的集合的完全限定域名匹配的正则表达式的数组。 |

|

| 不适用 | 可选字符串,它根据集合的列指定条件,用于捕获集合内容的子集。 |

触发临时快照

您可以通过在信号集合中添加带有 execute-snapshot 信号类型的条目来启动临时快照。连接器处理消息后,它会开始快照操作。快照过程读取第一个和最后一个主密钥值,并使用这些值作为每个集合的开始和端点。根据集合中条目数量以及配置的块大小,Debezium 将集合分成块,并一次为每个块进行快照。

4.2.3.2. 增量快照

增量快照是 Debezium MongoDB 连接器的技术预览功能。技术预览功能不被红帽产品服务级别协议(SLA)支持,且可能无法完成。因此,红帽不推荐在生产环境中实施任何技术预览功能。此技术预览功能为您提供对即将推出的产品创新的早期访问,允许您在开发过程中测试并提供反馈。如需有关支持范围的更多信息,请参阅 技术预览功能支持范围。

为了提供管理快照的灵活性,Debezium 包括一个补充的快照机制,称为 增量快照。增量快照依赖于 Debezium 机制 向 Debezium 连接器发送信号。

在增量快照中,而不是一次性捕获数据库的完整状态,如初始快照,Debezium 会在一系列可配置的块中捕获每个集合。您可以指定您希望快照捕获 的集合以及每个块的大小。块大小决定了快照在数据库的每个获取操作期间收集的行数。增量快照的默认块大小为 1 KB。

当增量快照进行时,Debezium 使用水位线来跟踪其进度,维护它捕获的每个集合行的记录。这个阶段捕获数据的方法比标准初始快照过程提供以下优点:

- 您可以使用流化数据捕获并行运行增量快照,而不是经过发布流,直到快照完成为止。连接器会继续在整个快照过程中从更改日志捕获接近实时事件,且操作都不会阻断其他事件。

- 如果增量快照的进度中断,您可以在不丢失任何数据的情况下恢复它。在进程恢复后,快照从停止的时间开始,而不是从开始回收集合。

-

您可以随时根据需要运行增量快照,并根据需要重复这个过程以适应数据库更新。例如,您可以在修改连接器配置后重新运行快照,以将集合添加到其

collection.include.list属性中。

增量快照过程

当您运行增量快照时,Debezium 按主密钥对集合进行排序,然后根据 配置的块大小 将集合分成块。然后,按块使用块,然后捕获块中的每个集合行。对于它捕获的每行,快照会发出 READ 事件。该事件代表了块开始快照时的行值。

当快照继续进行时,其他进程可能会继续访问数据库,从而可能会修改集合记录。要反映此类更改,INSERT、UPDATE 或 DELETE 操作会照常提交到事务日志中。同样,持续 Debezium 流过程还会继续检测这些更改事件,并将对应的更改事件记录发送到 Kafka。

Debezium 如何使用相同的主密钥解决记录间的冲突

在某些情况下,流传输进程发出的 UPDATE 或 DELETE 事件会耗尽序列。也就是说,流过程可能会发出一个事件,它会在快照捕获包含该行的 READ 事件前修改集合行。当快照最终会为行发出对应的 READ 事件时,其值已经被替换。为确保以正确的逻辑顺序处理到达序列的增量快照事件,Debezium 会使用一种缓冲区方案来解决冲突。只有在快照事件和流事件间冲突时才解决后,Debezium 会向 Kafka 发送事件记录。

快照窗口

为了帮助解决后续 READ 事件和修改同一集合行的流事件之间的冲突,Debezium 采用所谓的 快照窗口。快照窗口分离了增量快照捕获指定集合块的数据的时间间隔。在打开块的快照窗口前,Debebe 会遵循其常见的行为,并将事件直接从事务日志直接降级到目标 Kafka 主题。但是,从打开特定块的快照时,Debebe 会执行重复数据删除步骤,以解决具有相同主密钥的事件之间冲突。

对于每个数据收集,Debezium 会发出两种类型的事件,并将其记录存储在单个目标 Kafka 主题中。它直接从表中捕获的快照记录作为 READ 操作发出。同时,当用户继续更新数据收集中的记录,并更新事务日志以反映每个提交,Debezium 会为每个更改发出 UPDATE 或 DELETE 操作。

当快照窗口打开时,Debezium 开始处理快照块,它会将快照记录提供给内存缓冲区。在快照窗口中,缓冲区中 READ 事件的主键将与传入流事件的主键进行比较。如果没有找到匹配项,流的事件记录将直接发送到 Kafka。如果 Debezium 检测到匹配项,它会丢弃缓冲的 READ 事件,并将流的记录写入目标主题,因为流的事件逻辑地替换静态快照事件。在块的快照窗口关闭后,缓冲区仅包含没有相关事务日志事件的 READ 事件。Debezium 将这些剩余的 READ 事件发送到集合的 Kafka 主题。

连接器重复每个快照块的进程。

增量快照需要完全排序主密钥。但是,字符串 可能无法保证稳定的排序,因为编码和特殊字符可能会导致意外行为(Mongo 排序 字符串)。请考虑在执行增量快照时将其他类型用于主密钥。

目前,单个副本集部署只支持增量快照。

4.2.3.3. 触发增量快照

目前,启动增量快照的唯一方法是向源数据库上的 信号集合发送临时快照 信号。

您可以使用 MongoDB insert () 方法向信号集合提交信号。

在 Debezium 检测到信号集合中的更改后,它会读取信号,并运行请求的快照操作。

您提交的查询指定要包含在快照中的集合,以及可选的指定快照操作类型。目前,快照操作的唯一有效选项是默认值 增量。

要指定快照中包含的集合,提供一个 data-collections 数组,该数组列出了用于匹配集合的集合或一组正则表达式,例如{"data-collections": ["public.Collection1", "public.Collection2"]}

增量快照信号的 data-collections 数组没有默认值。如果 data-collections 数组为空,Debezium 会检测到不需要任何操作,且不执行快照。

如果要包含在快照中的集合名称包含数据库、模式或表名称的句点(.),则需要将集合添加到 data-collections 数组中,您必须用双引号转义名称的每个部分。

例如,若要包含 公共 数据库中存在的数据收集,并且名为 MyCollection,请使用以下格式:" public"."MyCollection "。

先决条件

- 源数据库中存在信号数据收集。

-

信号数据收集在

signal.data.collection属性中指定。

流程

将快照信号文档插入到信号集合中:

<signalDataCollection>.insert({"id" : _<idNumber>,"type" : <snapshotType>, "data" : {"data-collections" ["<collectionName>", "<collectionName>"],"type": <snapshotType>}});<signalDataCollection>.insert({"id" : _<idNumber>,"type" : <snapshotType>, "data" : {"data-collections" ["<collectionName>", "<collectionName>"],"type": <snapshotType>}});Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如,

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 命令中的

id、type和data参数的值对应于 信号集合的字段。下表描述了示例中的参数:

Expand 表 4.2. MongoDB insert ()命令中的字段描述,用于将增量快照信号发送到信号集合 项 值 描述 1

db.debeziumSignal指定源数据库上信号集合的完全限定名称。

2

null

_id参数指定分配给信号请求的id标识符的任意字符串。

上例中的插入方法省略了可选_id参数的使用。由于文档没有明确为该参数分配值,所以 MongoDB 会自动分配给文档的任意 id 成为信号请求的id标识符。

使用此字符串来标识到信号集合中条目的日志记录信息。Debezium 不使用此标识符字符串。相反,在快照中,Debebe 会生成自己的id字符串作为水位信号。3

execute-snapshot指定

type参数指定信号要触发的操作。

4

data-collections信号的

data字段所需的组件,用于指定集合名称或正则表达式数组,以匹配快照中包含的集合名称。

数组根据其完全限定名称列出与集合匹配的正则表达式,其格式与您用来在signal.data.collection配置属性中指定连接器的信号集合的名称相同。5

增量信号的

data字段的可选类型组件,用于指定要运行的快照操作类型。

目前,唯一有效选项是默认值增量。

如果没有指定值,连接器将运行一个增量快照。

以下示例显示了连接器捕获的增量快照事件的 JSON。

示例:增加快照事件信息

| 项 | 字段名称 | 描述 |

|---|---|---|

| 1 |

|

指定要运行的快照操作类型。 |

| 2 |

|

指定事件类型。 |

4.2.3.4. 停止增量快照

您还可以通过向源数据库上的集合发送信号来停止增量快照。您可以通过在信号集合中插入文档来提交停止快照信号。在 Debezium 检测到信号集合中的更改后,它会读取信号,并在进行时停止增量快照操作。

您提交的查询指定了 增量 的快照操作,以及可选的、要删除的当前运行快照的集合。

先决条件

- 源数据库中存在信号数据收集。

-

信号数据收集在

signal.data.collection属性中指定。

流程

将停止快照信号文档插入到信号集合中:

<signalDataCollection>.insert({"id" : _<idNumber>,"type" : "stop-snapshot", "data" : {"data-collections" ["<collectionName>", "<collectionName>"],"type": "incremental"}});<signalDataCollection>.insert({"id" : _<idNumber>,"type" : "stop-snapshot", "data" : {"data-collections" ["<collectionName>", "<collectionName>"],"type": "incremental"}});Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如,

Copy to Clipboard Copied! Toggle word wrap Toggle overflow signal 命令中的

id、type和data参数的值对应于 信号集合的字段。下表描述了示例中的参数:

Expand 表 4.3. 向信号集合发送停止增量快照文档的插入命令中字段的描述 项 值 描述 1

db.debeziumSignal指定源数据库上信号集合的完全限定名称。

2

null

上例中的插入方法省略了可选

_id参数的使用。由于文档没有明确为该参数分配值,所以 MongoDB 会自动分配给文档的任意 id 成为信号请求的id标识符。

使用此字符串来标识到信号集合中条目的日志记录信息。Debezium 不使用此标识符字符串。3

stop-snapshottype参数指定信号要触发的操作。

4

data-collections信号的

data字段的可选组件,用于指定集合名称或正则表达式数组,以匹配要从快照中删除的集合名称。

数组根据其完全限定名称列出与集合匹配的正则表达式,其格式与您用来在signal.data.collection配置属性中指定连接器的信号集合的名称相同。如果省略了data字段的此组件,则信号将停止正在进行的整个增量快照。5

增量信号的

data字段所需的组件,用于指定要停止的快照操作类型。

目前,唯一有效选项是增量的。

如果没有指定类型值,则信号无法停止增量快照。

4.2.4. Debezium MongoDB 连接器流更改事件记录

在副本设置的连接器任务记录偏移后,它会使用偏移来确定它应该启动流更改的 oplog 中的位置。然后,任务(取决于配置)连接到副本集的主节点,或连接到副本集范围的更改流,并开始从该位置更改流。它处理所有创建、插入和删除操作,并将其转换为 Debezium 更改事件。每个更改事件都包含找到操作的 oplog 中的位置,连接器会定期将其记录为其最新的偏移量。记录偏移的时间间隔取决于 offset.flush.interval.ms,它是一个 Kafka Connect worker 配置属性。

当连接器安全停止时,处理的最后一个偏移会被记录,以便在重启时,连接器将继续准确关闭位置。如果连接器的任务意外终止,则任务可能会在最后记录偏移后处理并生成事件,但在记录最后一个偏移前;重启后,连接器从上次 记录的 偏移开始,可能会生成之前在崩溃前生成的相同事件。

当 Kafka 管道中的所有组件无关时,Kafka 使用者 会完全 接收每个消息。但是,当出现错误时,Kafka 只能保证消费者 至少接收每个消息一次。为避免意外的结果,消费者必须能够处理重复的消息。

如前面所述,连接器任务总是使用副本集的主节点从 oplog 流更改,确保连接器尽可能查看最新的操作,并可以捕获比使用第二个延迟更低的更改。当副本集选择新主节点时,连接器会立即停止流更改,连接到新主节点,并从同一位置的新主节点启动流更改。同样,如果连接器遇到与副本集成员通信的问题,它会尝试使用 exponential backoff 来重新连接,以便不负担副本集,并连接后继续从最后离开的位置进行更改。这样,连接器可以动态调整副本设置成员资格中的更改,并自动处理通信失败。

为了总结,MongoDB 连接器在大多数情况下继续运行。通信问题可能会导致连接器等待直到问题解决为止。

4.2.5. MongoDB 支持在 Debezium 更改事件中填充 before 字段

在 MongoDB 6.0 及更高版本中,您可以配置更改流,以发出文档的预镜像状态,以填充 MongoDB 更改事件的 before 字段。要在 MongoDB 中启用预镜像,您必须使用 db. 、创建或 create Collection ()collMod 为集合设置 changeStreamPreAndPostImages。要使 Debezium MongoDB 在更改事件中包含 pre-images,请将连接器的 capture.mode 设置为 一 一 一 一,with_pre_image 选项。

MongoDB 更改流事件的大小限制为 16MB。因此,使用预镜像会增加这个阈值的可能性,这可能会导致失败。有关如何避免超过更改流限制的详情,请参考 MongoDB 文档。

4.2.6. 接收 Debezium MongoDB 更改事件记录的 Kafka 主题默认名称

MongoDB 连接器将所有插入、更新和删除操作写入事件,将每个集合中的操作写入单个 Kafka 主题。Kafka 主题的名称始终使用 logicalName.databaseName.collectionName 格式,其中 logical Name 是连接器的逻辑名称,如 topic.prefix 配置属性,databaseName 是发生操作的数据库的名称,collectionName 是受影响的文档存在的 MongoDB 集合的名称。

例如,假设一个 MongoDB 副本集有一个 inventory 数据库,其中包含四个集合:products, products_on_hand, customers, 和 orders。如果监控这个数据库的连接器有一个逻辑名称 fulfillment,则这个连接器会在这四个 Kafka 主题上生成事件:

-

fulfillment.inventory.products -

fulfillment.inventory.products_on_hand -

fulfillment.inventory.customers -

fulfillment.inventory.orders

请注意,主题名称不包含副本集名称或分片名称。因此,对分片集合的所有更改(每个分片都包含集合文档的子集)都属于相同的 Kafka 主题。

您可以根据需要将 Kafka 设置为自动创建主题。https://kafka.apache.org/documentation.html#basic_ops_add_topic如果没有,则必须使用 Kafka 管理工具在启动连接器前创建主题。

4.2.7. Debezium MongoDB 连接器的事件键控制主题分区的方式

MongoDB 连接器不会明确决定如何为事件分区主题。相反,它允许 Kafka 根据事件密钥决定如何对主题进行分区。您可以通过在 Kafka Connect worker 配置中定义 Partitioner 实现来更改 Kafka 的分区逻辑。

Kafka 仅在写入单个主题分区的事件维护总顺序。按键对事件进行分区意味着所有具有相同键的事件始终都进入同一分区。这样可确保特定文档的所有事件始终被完全排序。

4.2.8. Debezium MongoDB 连接器生成的事件代表事务边界

Debezium 可以生成代表事务元数据边界的事件,并增强更改数据事件消息。

Debezium 仅在部署连接器后为发生的事务注册并接收元数据。部署连接器前发生的事务元数据。

对于每个事务 BEGIN 和 END,Debezium 生成一个包含以下字段的事件:

status-

BEGIN或END id- 唯一事务标识符的字符串表示。

event_count(用于END事件)- 事务发出的事件总数。

data_collections(用于END事件)-

data_collection和event_count对,它提供了由来自给定数据收集的更改所发出的事件数量。

以下示例显示了典型的信息:

除非通过 topic.transaction 选项覆盖,否则事务事件将写入名为 <topic. prefix>。

.transaction 的主题

更改数据事件增强

如果启用了事务元数据,数据消息 Envelope 会增加一个新的 transaction 字段。此字段以字段复合的形式提供有关每个事件的信息:

id- 唯一事务标识符的字符串表示。

total_order- 事件在事务生成的所有事件的绝对路径。

data_collection_order- 事件在事务发送的所有事件中每个数据收集位置。

以下是信息类似如下的示例:

4.3. Debezium MongoDB 连接器数据更改事件的描述

Debezium MongoDB 连接器为每个插入、更新或删除数据的文档级别操作生成数据更改事件。每个事件都包含一个键和值。键和值的结构取决于更改的集合。

Debezium 和 Kafka Connect 围绕 事件消息的持续流 设计。但是,这些事件的结构可能会随时间而变化,而用户很难处理这些事件。要解决这个问题,每个事件都包含其内容的 schema,或者如果您使用 schema registry,则消费者可以从 registry 获取 schema 的模式 ID。这使得每个事件都可以自我包含。

以下框架 JSON 显示更改事件的基本四个部分。但是,如何配置在应用程序中使用的 Kafka Connect converter 决定了更改事件中的这四个部分的表示。只有当您将转换器配置为生成它时,schema 字段才处于更改事件中。同样,只有在将转换器配置为生成它时,才会发生更改事件中的事件密钥和事件有效负载。如果您使用 JSON 转换器,并将其配置为生成所有四个基本更改事件部分,则更改事件具有此结构:

| 项 | 字段名称 | 描述 |

|---|---|---|

| 1 |

|

第一个 |

| 2 |

|

第一个 |

| 3 |

|

第二个 |

| 4 |

|

第二个 |

默认情况下,连接器流将事件记录更改为名称与事件原始集合相同的名称的主题。请参阅 主题名称。

MongoDB 连接器确保所有 Kafka Connect 模式名称都遵循 Avro 模式名称格式。这意味着,逻辑服务器名称必须以拉丁或下划线开头,即 a-z、A-Z 或 _。逻辑服务器名称中的每个剩余的字符以及数据库和集合名称中的每个字符都必须是一个字母、数字或下划线,即 a-z、A-Z、0-9 或 \_。如果存在无效的字符,它将替换为下划线字符。

如果逻辑服务器名称、数据库名称或集合名称包含无效字符,且区分另一个名称的唯一字符无效,则可能会导致意外冲突,因此替换为下划线。

如需更多信息,请参阅以下主题:

4.3.1. 关于 Debezium MongoDB 更改事件中的键

更改事件的密钥包含更改文档的密钥的 schema,以及更改的文档的实际密钥。对于给定集合,schema 及其对应有效负载都包含单个 id 字段。此字段的值是文档的标识符,表示为来自 MongoDB 扩展 JSON 序列化严格模式的字符串。

考虑一个连接器,其逻辑名称为 fulfillment,包括一个 inventory 数据库的副本集,以及包含如下文档的 customers 集合。

文档示例

更改事件键示例

捕获对 customers 集合的更改的每个更改事件都有相同的事件键模式。只要 customers 集合有以前的定义,捕获 客户 集合更改的事件都有以下关键结构:在 JSON 中,它类似如下:

| 项 | 字段名称 | 描述 |

|---|---|---|

| 1 |

|

键的 schema 部分指定一个 Kafka Connect 模式,它描述了密钥 |

| 2 |

|

定义密钥有效负载结构的 schema 名称。这个模式描述了文档的密钥结构。Key 模式名称的格式为 connector-name.database-name.collection-name.

|

| 3 |

|

指明 event 键必须在其 |

| 4 |

|

指定 |

| 5 |

|

包含生成此更改事件的文档的密钥。在本例中,键包含一个类型为 |

本例使用带有整数标识符的文档,但任何有效的 MongoDB 文档标识符都的工作方式相同,包括文档标识符。对于文档标识符,事件的 payload.id 值是一个字符串,它代表更新的文档的原始 _id 字段作为一个 MongoDB 扩展 JSON 序列化,它使用严格的模式。下表提供了如何表示不同类型的 _id 字段的示例。

| 类型 | MongoDB _id Value | 密钥的有效负载 |

|---|---|---|

| 整数 | 1234 |

|

| 浮点值 | 12.34 |

|

| 字符串 | "1234" |

|

| 文档 |

|

|

| ObjectId |

|

|

| 二进制 |

|

|

4.3.2. 关于 Debezium MongoDB 更改事件中的值

更改事件中的值比键稍微复杂。与键一样,该值具有 schema 部分和 payload 部分。schema 部分包含描述 payload 部分的 Envelope 结构的 schema,包括其嵌套字段。更改创建、更新或删除数据的事件,并且具有 envelope 结构的值有效负载。

考虑用于显示更改事件键示例的相同示例文档:

文档示例

对每个事件类型都描述了更改事件的值部分:

创建 事件

以下示例显示了连接器为 在客户 集合中创建数据的操作生成的更改事件的值部分:

| 项 | 字段名称 | 描述 |

|---|---|---|

| 1 |