仪表板指南

使用 Ceph 控制面板监控 Ceph 集群

摘要

第 1 章 Ceph 仪表板概述

作为存储管理员,Red Hat Ceph Storage 控制面板提供管理和监控功能,允许您管理和配置集群,以及与它相关的视觉化信息和性能统计信息。控制面板使用由 ceph-mgr 守护进程托管的 Web 服务器。

控制面板可从 Web 浏览器访问,包括许多有用的管理和监控功能,例如配置管理器模块并监控 OSD 的状态。

1.1. 先决条件

- 系统管理员级别经验.

1.2. 仪表板组件

仪表板的功能由多个组件提供。

- 用于部署的 Ansible 自动化应用。

-

嵌入式仪表板

ceph-mgr模块。 -

嵌入的 Prometheus

ceph-mgr模块。 - Prometheus 时间序列数据库。

- Prometheus node-exporter 守护进程,在存储集群的每个节点中运行。

- 用于监控用户界面和警报的 Grafana 平台。

其它资源

- 如需更多信息,请参阅 Ansible 网站

- 如需更多信息,请参阅 Prometheus 网站。

- 如需更多信息,请参阅 Grafana 网站。

1.3. 仪表板功能

Ceph 控制面板提供多个功能。

管理功能

- 查看集群层次结构 :您可以查看 CRUSH map,例如,确定运行特定 OSD ID 的节点。如果 OSD 存在问题,这很有用。

- 配置管理器模块 :您可以查看和更改 ceph 管理器模块的参数。

- 查看并过滤日志 :您可以查看事件和审计日志,并根据优先级、关键字、日期或时间范围过滤它们。

- 切换仪表板组件 :您可以启用和禁用仪表板组件,以便只有需要的功能可用。

- 管理 OSD 设置 :您可以使用控制面板设置集群范围的 OSD 标志。

- 查看警报 :警报页面允许您查看当前警报的详情。

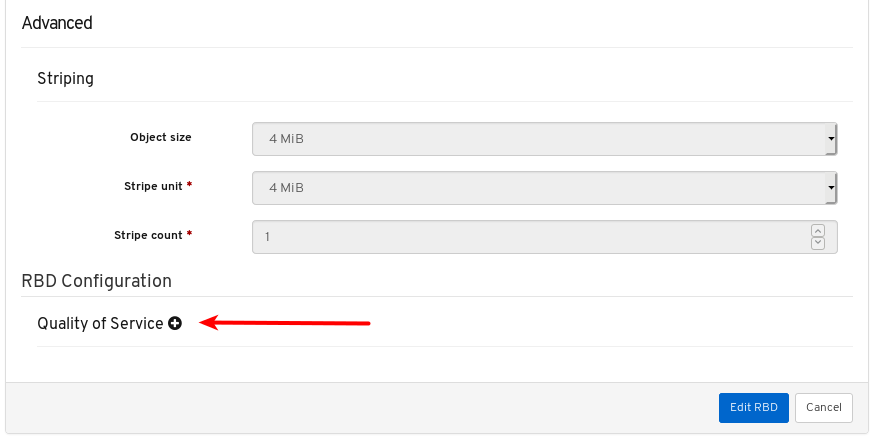

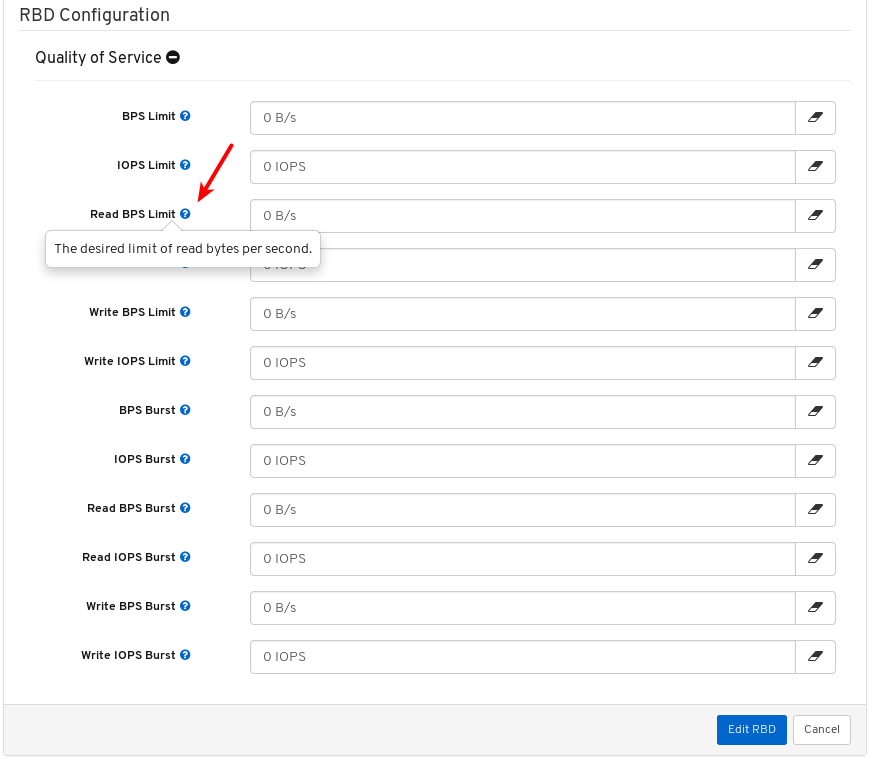

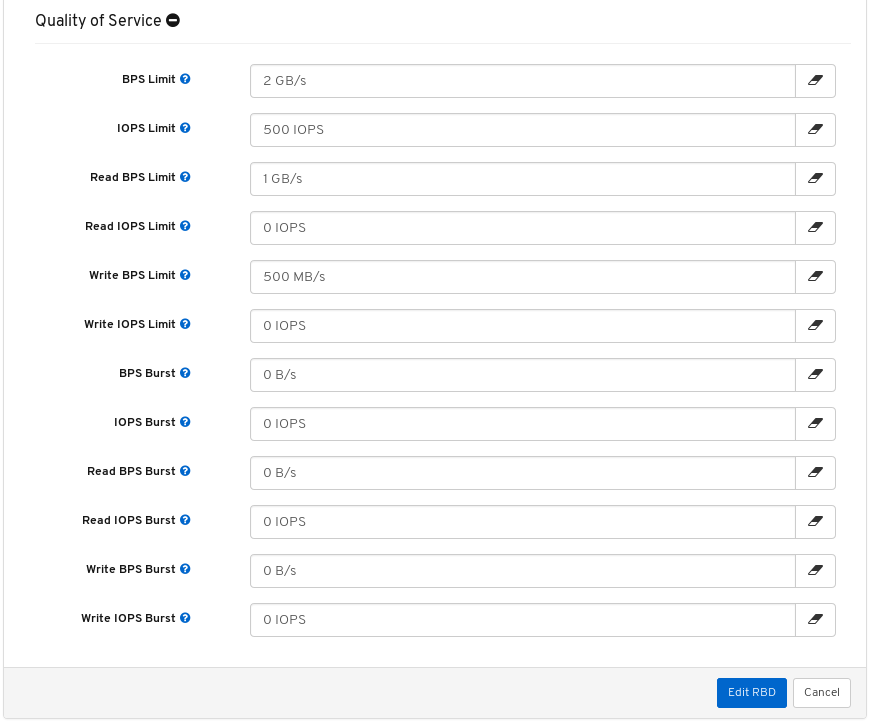

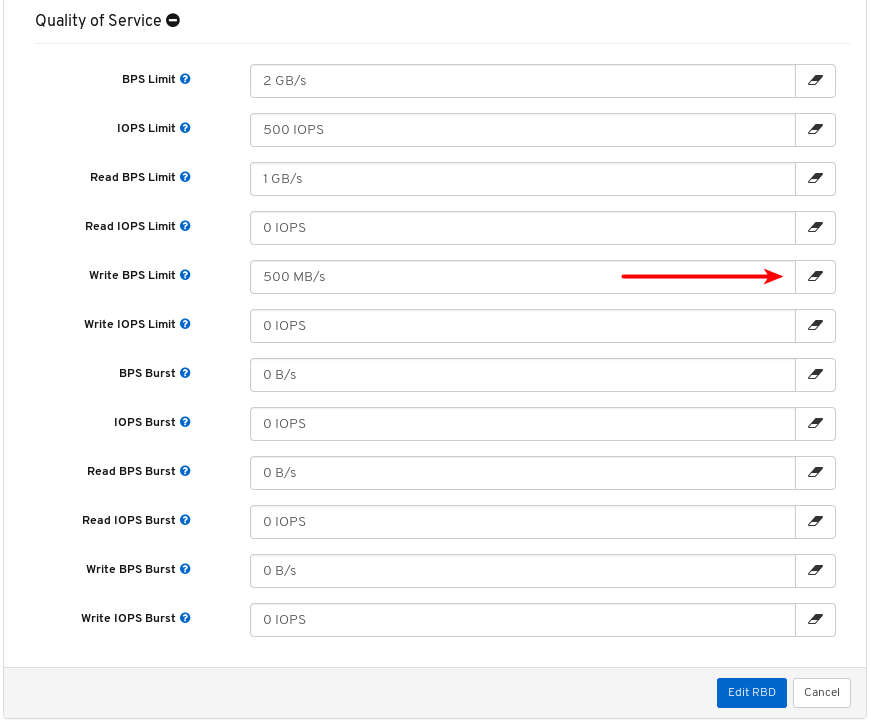

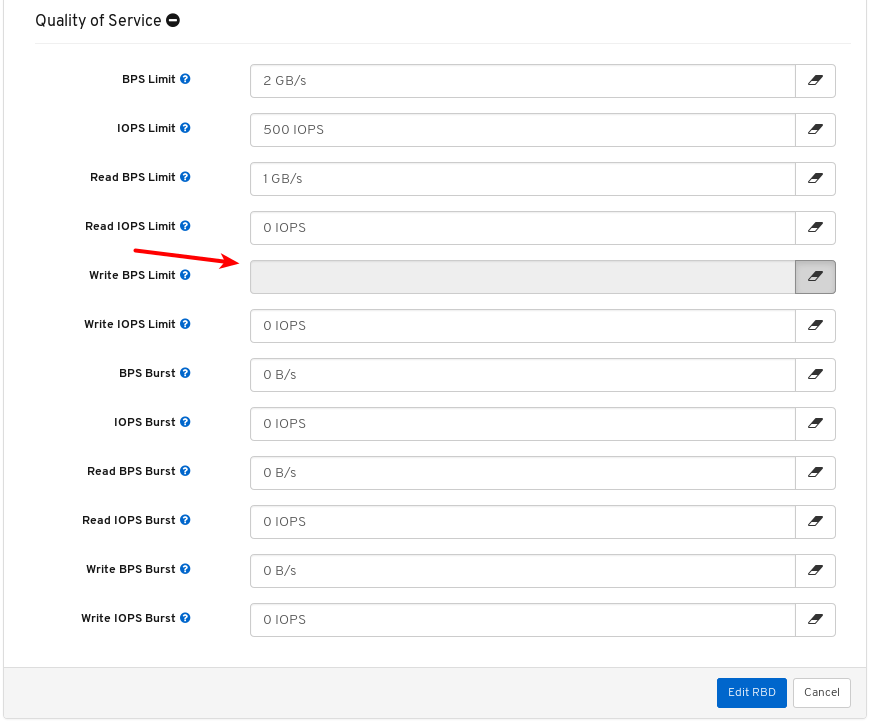

- 镜像的服务质量 :您可以为镜像设置性能限制,例如限制 IOPS 或读取 BPS burst 率。

监控功能

- 用户名和密码保护 :您只能通过提供可配置的用户名和密码来访问控制面板。

SSL 和 TLS 支持 :Web 浏览器和控制面板之间的所有 HTTP 通信均通过 SSL 保护。可以使用内置 命令创建自签名证书,但也可以导入证书颁发机构(CA)签名的证书。从 Red Hat Ceph Storage 4.2,

dashboard_protocol设置为https,Ansible 会生成仪表板和 grafana 证书。要绘图数据点和图表,请手动更新 TLS 握手:- 警报管理器 API 主机 - http://grafana_node:9093

- Prometheus API 主机 - http://grafana_node:9092

- Grafana API 主机 - https://grafana_node:3000

- 总体集群健康状况 :显示集群总体状态、存储利用率(如对象的数量、原始容量、每个池使用量)、池列表及其状态和使用统计。

- 主机 :提供与集群关联的所有主机列表,以及正在运行的服务和已安装的 Ceph 版本。

- 性能计数器 :显示每个正在运行的服务的详细统计信息。

- Monitors: 列出所有 monitor、其仲裁状态和打开的会话。

- Configuration Reference :列出所有可用的配置选项、其描述和默认值。

- 集群日志 :显示和过滤集群的事件和审计日志。

- 查看存储集群容量 :您可以在 Ceph 控制面板的 Capacity 面板中查看 Red Hat Ceph Storage 集群的原始存储容量。

- 池 :列出和管理所有 Ceph 池及其详细信息。例如:应用程序、放置组、复制大小、EC 配置文件、CRUSH 规则集等。

- OSD :列出和管理所有 OSD、其状态和使用量统计数据,以及属性(OSD map)、元数据、性能计数器和用于读取/写入操作等详细信息。

- iSCSI :列出运行 tcmu-runner 服务的所有主机,显示所有镜像及其性能特征,如读取和写入操作或流量。

镜像 :列出所有 RBD 镜像及其属性,如 size、object 和 features。创建、复制、修改和删除 RBD 镜像。创建、删除和回滚所选镜像的快照,防止或取消防止这些快照进行修改。复制或克隆快照,扁平化克隆的镜像。

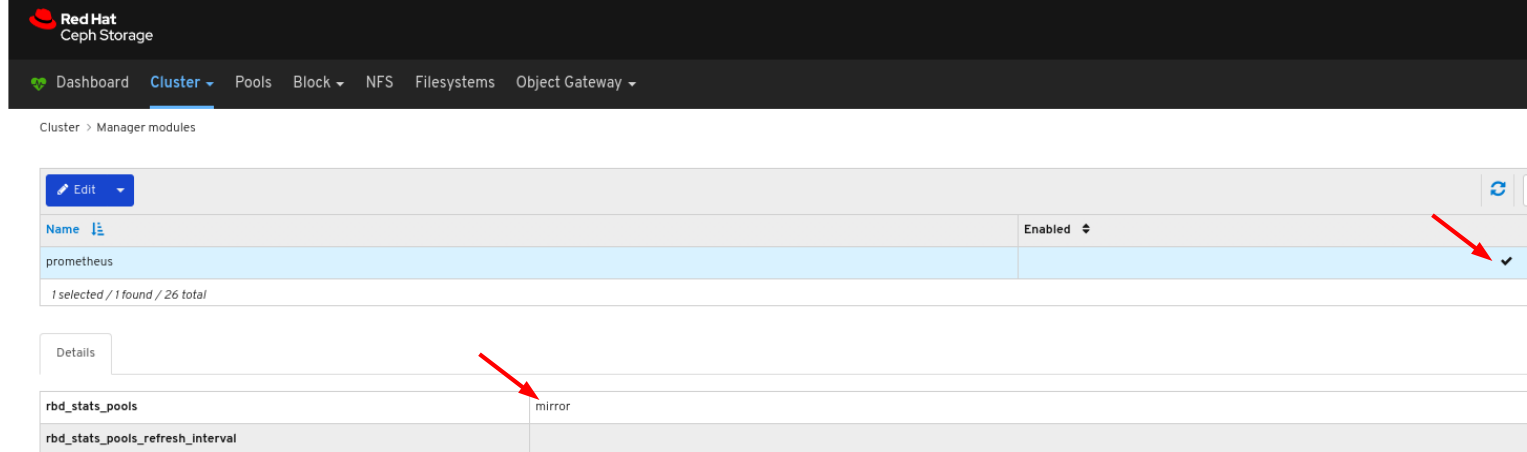

注意特定镜像的 Overall Performance 选项卡中的 I/O 性能图仅在指定包含该镜像的池后,才会通过在 Cluster > Manager 模块 > Prometheus 中设置

rbd_stats_pool参数。- 镜像功能 :列出所有活跃同步守护进程及其状态、池和 RBD 镜像,包括它们的同步状态。

- 文件系统 :列出所有活动 Ceph 文件系统(CephFS)客户端和相关池,包括它们的使用量统计数据。

- 对象网关(RGW) :列出所有活动对象网关及其性能计数器。显示和管理(添加、编辑、删除)对象网关用户及其详细信息(如配额),以及用户的存储桶及其详细信息,如所有者或配额。

其它资源

- 如需更多信息,请参阅 Red Hat Ceph Storage Dashboard 指南中的 切换仪表板组件 。

1.3.1. 在或关闭或关闭仪表板功能

您可以通过根据需要启用或禁用功能来自定义 Red Hat Ceph Storage 仪表板组件。所有功能都默认启用。禁用某一功能时,web 接口元素变得隐藏,相关的 REST API 端点会拒绝对该功能的任何进一步请求。启用和禁用仪表板功能可以通过命令行界面或 Web 界面完成。

可用功能:

Ceph 块设备:

-

镜像管理,

rbd -

镜像、镜像、

镜像 -

iSCSI 网关,

iscsi

-

镜像管理,

-

Ceph 文件系统,

cephfs -

Ceph 对象网关,

rgw

默认情况下,Ceph Manager 与 Ceph Monitor 共存。

您可以一次性禁用多个功能。

禁用某个功能后,可能需要 20 秒来反映 web 界面中的更改。

先决条件

- 安装和配置红帽 Ceph 存储仪表板软件。

- 用户访问 Ceph 管理器节点或控制面板 Web 界面。

流程

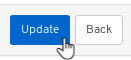

从仪表板 Web 界面切换仪表板功能:

- 在仪表板页面中的导航栏中,导航到 Cluster,再单击 Manager Modules,然后单击 Dashboard。这将打开 Edit Manager 模块 页面。

在 Edit Manager 模块 页面中,您可以通过选中或取消选中功能名称旁边的选择框来启用或禁用仪表板功能。

完成选择后,单击页面底部的 Update 按钮。

使用命令行界面切换仪表板功能:

- 登录 Ceph 管理器节点。

列出功能状态:

ceph dashboard feature status

[user@mon ~]$ ceph dashboard feature statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow 禁用一个功能:

ceph dashboard feature disable iscsi

[user@mon ~]$ ceph dashboard feature disable iscsiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 本例禁用 Ceph iSCSI 网关功能。

启用功能:

ceph dashboard feature enable cephfs

[user@mon ~]$ ceph dashboard feature enable cephfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 这个示例启用了 Ceph Filesystem 功能。

1.4. 仪表板架构

控制面板架构取决于 Ceph 管理器仪表板插件和其他组件。查看下图以了解它们如何协同工作。

第 2 章 Ceph 控制面板安装和访问

作为系统管理员,您可以安装仪表板并第一次访问它。

Red Hat Ceph Storage 使用 Cockpit Web 界面或使用 ceph-ansible RPM 提供的 Ansible playbook 在命令行中安装。Cockpit 使用相同的 Ansible playbook 来安装 Ceph。这些 playbook 默认安装控制面板。因此,无论您直接使用 Ansible playbook,或者使用 Cockpit 安装 Ceph,都会安装控制面板。

更改默认仪表板密码。默认情况下,仪表板的密码是 p@ssw0rd,它不安全。在使用 playbook 安装 Ceph 前,或者使用相同的 playbook 或控制面板本身安装后,您可以先更新 all.yml Ansible playbook 中的 dashboard_admin_password 来更改默认密码。有关更多信息,请参阅 《安装指南》、使用控制面板更改控制面板密码或 使用 Ansible 更改仪表板密码。

2.1. 使用 Cockpit 安装仪表板

使用 Cockpit Web 界面安装 Red Hat Ceph Storage 时,会默认安装控制面板。您必须使用安装 Grafana 的 Metrics 角色设置主机。

先决条件

- 有关完整先决条件,请参阅 安装指南。此流程只会突出显示与仪表板安装相关的步骤。

流程

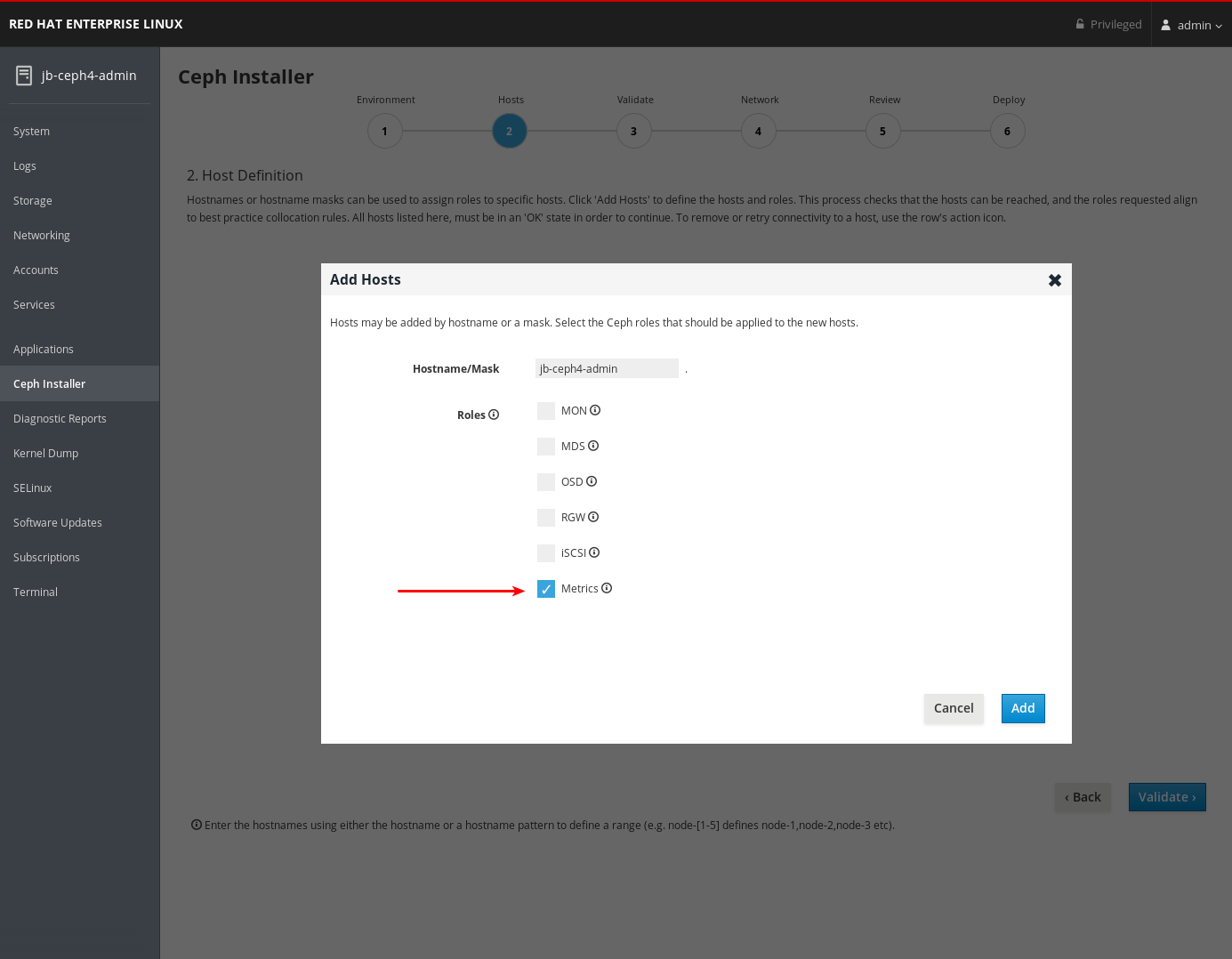

在 Hosts 页面上,添加一个主机并设置 Metrics 角色。

- 点 Add。

- 完成剩余的 Cockpit Ceph Installer 提示。

部署过程完成后,单击页面底部的 完成 按钮。这将打开一个窗口,显示命令

ceph status的输出,以及控制面板访问信息。在 Ceph Cluster Status 窗口的底部,会显示控制面板访问信息,包括 URL、用户名和密码。记录此信息。

- 有关更多信息,请参阅 《安装指南》 中的使用 Cockpit Web 用户界面安装 Red Hat Ceph Storage。

2.2. 使用 Ansible 安装仪表板

在使用 ceph-ansible RPM 提供的 Ansible playbook 安装 Red Hat Ceph Storage 时,会默认安装控制面板。

先决条件

- 有关完整先决条件,请参阅 安装指南。此流程只会突出显示与仪表板安装相关的步骤。

流程

确保 Ansible 清单文件中存在具有定义节点的

[grafana-server]组。Grafana 和 Prometheus 已安装在这个节点上。grep grafana-server -A 1 /etc/ansible/hosts

[root@jb-ceph4-admin ~]# grep grafana-server -A 1 /etc/ansible/hosts [grafana-server] jb-ceph4-monCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

all.ymlAnsible playbook 中,确保dashboard_enabled:尚未设置为False。应有一个注释,表示默认设置为True。grep "dashboard_enabled" /usr/share/ceph-ansible/group_vars/all.yml

[root@jb-ceph4-admin ~]# grep "dashboard_enabled" /usr/share/ceph-ansible/group_vars/all.yml #dashboard_enabled: TrueCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 按照 安装指南 中所述,完成安装 Ceph 所需的其余步骤。

运行

ansible-playbook site.yml用于裸机安装,或ansible-playbook site-docker.yml用于容器安装,Ansible 将打印仪表板访问信息。找到 playbook 输出末尾的仪表板 URL、用户名和密码:2019-12-13 15:31:17,871 p=11421 u=admin | TASK [ceph-dashboard : print dashboard URL] ************************************************************ 2019-12-13 15:31:17,871 p=11421 u=admin | task path: /usr/share/ceph-ansible/roles/ceph-dashboard/tasks/main.yml:5 2019-12-13 15:31:17,871 p=11421 u=admin | Friday 13 December 2019 15:31:17 -0500 (0:00:02.189) 0:04:25.380 ******* 2019-12-13 15:31:17,934 p=11421 u=admin | ok: [jb-ceph4-mon] => msg: The dashboard has been deployed! You can access your dashboard web UI at http://jb-ceph4-mon:8443/ as an 'admin' user with 'p@ssw0rd' password.

2019-12-13 15:31:17,871 p=11421 u=admin | TASK [ceph-dashboard : print dashboard URL] ************************************************************ 2019-12-13 15:31:17,871 p=11421 u=admin | task path: /usr/share/ceph-ansible/roles/ceph-dashboard/tasks/main.yml:5 2019-12-13 15:31:17,871 p=11421 u=admin | Friday 13 December 2019 15:31:17 -0500 (0:00:02.189) 0:04:25.380 ******* 2019-12-13 15:31:17,934 p=11421 u=admin | ok: [jb-ceph4-mon] => msg: The dashboard has been deployed! You can access your dashboard web UI at http://jb-ceph4-mon:8443/ as an 'admin' user with 'p@ssw0rd' password.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 记录输出,

您可以在 http://jb-ceph4-mon:8443/ 中作为"p@ssw0rd"密码访问仪表板 Web UI。

Ansible playbook 执行以下操作:

-

在

ceph-mgr中启用 Prometheus 模块。 -

在

ceph-mgr中启用 dashboard 模块,并打开 TCP 端口 8443。 将 Prometheus

node_exporter守护进程部署到存储集群中的每个节点。- 打开 TCP 端口 9100。

-

启动

node_exporter守护进程。

在 Ansible 清单文件中的

[grafana-server]下,在 Docker/systemd 下部署 Grafana 和 Prometheus 容器。- 配置 Prometheus,以从 ceph-mgr 节点和每个 Ceph 主机上运行的 node-exporters 收集数据

- 打开 TCP 端口 3000。

- 在 Grafana 中创建仪表板、主题和用户帐户。

- 显示 Ceph 控制面板登录页面 URL。

2.3. 网络端口要求

Ceph 仪表板组件使用某些必须可以被访问的 TCP 网络端口。默认情况下,在安装 Red Hat Ceph Storage 时,在 firewalld 中自动打开网络端口。

| 端口 | 使用 | 原始节点 | 目标节点 |

|---|---|---|---|

| 8443 | 仪表板 Web 界面 |

在 Ansible 清单文件中需要访问 Ceph 控制面板 UI 和节点 | Ceph 管理器节点。 |

| 3000 | Grafana |

需要访问 Grafana Dashboard UI 和所有 Ceph Manager 主机 |

Ansible 清单文件中 |

| 9090 | 基本 Prometheus 图形的默认 Prometheus 服务器 |

需要访问 Prometheus UI 和所有 Ceph Manager 主机以及 |

Ansible 清单文件中 |

| 9092 | 用于基本 Prometheus 图形的 Prometheus 服务器 |

需要访问 Prometheus UI 和所有 Ceph Manager 主机以及 |

Ansible 清单文件中 |

| 9093 | Prometheus Alertmanager |

需要访问 Alertmanager Web UI 和所有 Ceph Manager 主机以及 |

所有 Ceph Manager 节点以及 Ansible 清单文件中的 |

| 9094 | Prometheus Alertmanager 可配置从多个实例组成的高可用性集群 |

所有 Ceph Manager 节点以及 Ansible 清单文件中的 |

Prometheus Alertmanager High Availability(对等点守护进程同步),因此 |

| 9100 |

Prometheus |

运行 Prometheus 的主机,需要查看节点导出器指标 Web UI 和所有 Ceph Manager 节点以及 |

所有存储集群节点,包括 MON、OSDS、 |

| 9283 | Ceph Manager Prometheus exporter 模块 |

运行 Prometheus 的主机需要访问 Ceph Exporter 指标 Web UI 和 | 所有 Ceph 管理器节点。 |

| 9287 | Ceph iSCSI 网关数据 |

所有 Ceph 管理器主机 和 | 所有 Ceph iSCSI 网关节点。 |

2.4. 配置仪表板端口

Red Hat Ceph Storage 控制面板默认绑定到 TCP/IP 地址和 TCP 端口。

默认情况下,当 SSL 禁用时,托管仪表板的 ceph-mgr 守护进程绑定到 TCP 端口 8443 或 8080。如果没有配置特定地址,Web 应用绑定到 ::,它对应于所有可用 IP4 和 IP6 地址。

您可以使用集群范围级别的配置密钥工具更改 IP 地址和端口。

先决条件

- 红帽 Ceph 存储集群.

- 安装红帽 Ceph 存储仪表板.

- 所有节点的根级别访问权限。

流程

获取用于访问仪表板的 URL:

示例

ceph mgr services

[root@admin ~]# ceph mgr servicesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 获取

ceph-mgr守护进程的当前 IP 和端口配置:示例

netstat -ntlp

[root@admin ~]# netstat -ntlpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 设置 IP 地址和端口:

语法

ceph config set mgr mgr/dashboard/server_addr IP_ADDRESS ceph config set mgr mgr/dashboard/server_port PORT ceph config set mgr mgr/dashboard/ssl_server_port PORT

ceph config set mgr mgr/dashboard/server_addr IP_ADDRESS ceph config set mgr mgr/dashboard/server_port PORT ceph config set mgr mgr/dashboard/ssl_server_port PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

ceph config set mgr mgr/dashboard/server_addr 192.168.0.120 ceph config set mgr mgr/dashboard/server_port 8443 ceph config set mgr mgr/dashboard/ssl_server_port 8443

[root@mon ~]# ceph config set mgr mgr/dashboard/server_addr 192.168.0.120 [root@mon ~]# ceph config set mgr mgr/dashboard/server_port 8443 [root@mon ~]# ceph config set mgr mgr/dashboard/ssl_server_port 8443Copy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:由于

ceph-mgr托管自己的仪表板实例,您可以单独配置它们。更改特定管理器实例的 IP 地址和端口:语法

ceph config set mgr mgr/dashboard/NAME/server_addr IP_ADDRESS ceph config set mgr mgr/dashboard/NAME/server_port PORT ceph config set mgr mgr/dashboard/NAME/ssl_server_port PORT

ceph config set mgr mgr/dashboard/NAME/server_addr IP_ADDRESS ceph config set mgr mgr/dashboard/NAME/server_port PORT ceph config set mgr mgr/dashboard/NAME/ssl_server_port PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将:NAME 替换为托管仪表板的

ceph-mgr实例的 ID。示例

ceph config set mgr mgr/dashboard/mgrs-0/server_addr 192.168.0.120 ceph config set mgr mgr/dashboard/mgrs-0/server_port 8443 ceph config set mgr mgr/dashboard/mgrs-0/ssl_server_port 8443

[root@mon ~]# ceph config set mgr mgr/dashboard/mgrs-0/server_addr 192.168.0.120 [root@mon ~]# ceph config set mgr mgr/dashboard/mgrs-0/server_port 8443 [root@mon ~]# ceph config set mgr mgr/dashboard/mgrs-0/ssl_server_port 8443Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5. 访问仪表板

通过访问控制面板,您可以管理和监控 Red Hat Ceph Storage 集群。

先决条件

- 成功安装 Red Hat Ceph Storage 仪表板。

- NTP 正确同步时钟。

当节点没有正确同步时,可在仪表板节点、集群节点和浏览器之间发生时间布局。确保所有节点和浏览器运行的系统均由 NTP 同步。默认情况下,部署 Red Hat Ceph Storage 时,Ansible 会在所有节点上配置 NTP。要验证,对于 Red Hat Enterprise Linux 7,请参阅 使用 ntpd 配置 NTP,对于 Red Hat Enterprise Linux 8 ,请参阅 使用 Chrony 套件配置 NTP。如果您在另一个操作系统上运行浏览器,请查阅该操作系统厂商的 NTP 配置信息。

当在 Red Hat Ceph Storage 中使用 OpenStack Platform(OSP)时,要启用 OSP Safe 模式,请使用以下方法之一。使用 Ansible,编辑 group_vars/all.yml Ansible playbook,分别为 dashboard_admin_user_ro: true 和重新运行 ansible-playbook,或者针对 site.yml 或 site-container.yml 分别用于裸机或容器部署。要使用 ceph 命令启用 OSP Safe 模式,请运行 。为了确保运行 ceph dashboard ac-user-set-roles admin read-onlyceph-ansible Ansible playbook,编辑 group_vars/all.yml 并设置 dashboard_admin_user_ro: true,以确保更改保留。

流程

在网页浏览器中输入以下 URL:

http://HOST_NAME:PORT

http://HOST_NAME:PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 替换:

- HOST_NAME,其主机名为控制面板节点。

使用端口

8443的 PORT例如:

http://dashboard:8443

http://dashboard:8443Copy to Clipboard Copied! Toggle word wrap Toggle overflow

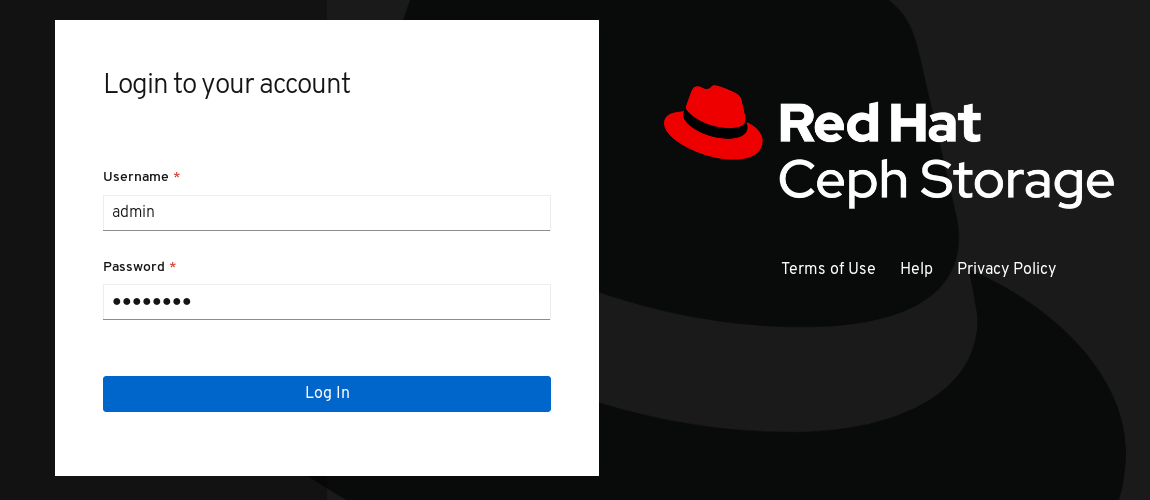

在登录页面中,输入用户名

admin和密码p@ssw0rd(如果您在安装过程中没有更改密码)。图 2.1. Ceph Dashboard 登录页

登录后,会显示仪表板默认登录页面,其中提供了 Red Hat Ceph Storage 集群的状态、性能和容量指标的高级别概述。

图 2.2. Ceph Dashboard Default Landing Page

其它资源

- 如需更多信息,请参阅控制面板指南中的使用 控制面板 更改仪表板密码。

- 如需更多信息,请参阅 控制面板 指南中的使用 Ansible 更改仪表板密码。

2.6. 使用 Ansible 更改仪表板密码

默认情况下,用于访问仪表板的密码设置为 p@ssw0rd。

出于安全考虑,在安装后更改密码。

您可以使用 Ansible 更改仪表板密码。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 访问 Ansible 管理节点.

流程

-

打开 Ansible playbook 文件

/usr/share/ceph-ansible/group_vars/all.yml进行编辑。 取消注释并更新此行中的密码:

#dashboard_admin_password: p@ssw0rd

#dashboard_admin_password: p@ssw0rdCopy to Clipboard Copied! Toggle word wrap Toggle overflow 改为:

dashboard_admin_password: NEW_PASSWORD

dashboard_admin_password: NEW_PASSWORDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将 NEW_PASSWORD 替换为您的首选密码。

再次运行部署或更新 Ceph 集群的 Ansible playbook 文件。

对于裸机安装,请使用

site.ymlplaybook:ansible-playbook -v site.yml

[admin@admin ceph-ansible]$ ansible-playbook -v site.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 对于容器安装,请使用

site-docker.ymlplaybook:ansible-playbook -v site-docker.yml

[admin@admin ceph-ansible]$ ansible-playbook -v site-docker.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- 使用新密码登录。

2.7. 使用仪表板更改仪表板密码

默认情况下,用于访问仪表板的密码设置为 p@ssw0rd。

出于安全考虑,在安装后更改密码。

若要使用控制面板更改密码,还要更改 Ansible 中的控制面板密码设置,确保如果 Ansible 用于重新配置 Red Hat Ceph Storage 集群,则密码不会恢复到默认密码。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

流程

更新

group_vars/all.yml文件中的密码,以防止在 Ansible 用于重新配置 Ceph 集群时将密码重置为p@ssw0rd。-

打开 Ansible playbook 文件

/usr/share/ceph-ansible/group_vars/all.yml进行编辑。 取消注释并更新此行中的密码:

#dashboard_admin_password: p@ssw0rd

#dashboard_admin_password: p@ssw0rdCopy to Clipboard Copied! Toggle word wrap Toggle overflow 改为:

dashboard_admin_password: NEW_PASSWORD

dashboard_admin_password: NEW_PASSWORDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将 NEW_PASSWORD 替换为您的首选密码。

-

打开 Ansible playbook 文件

在 Dashboard web user-interface 中更改密码。

登录到仪表板:

http://HOST_NAME:8443

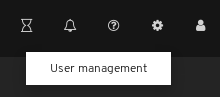

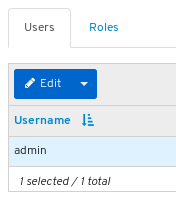

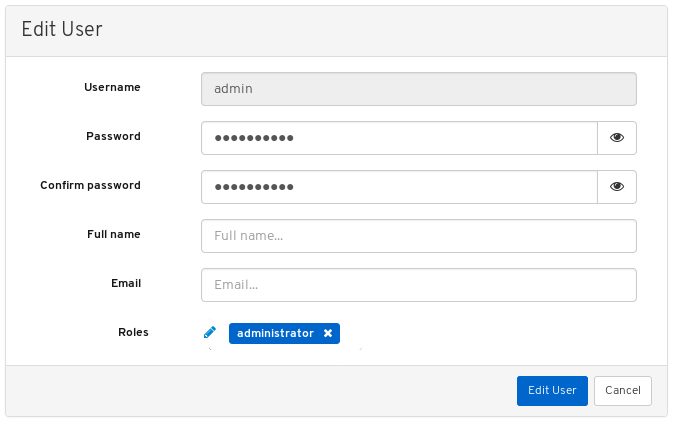

http://HOST_NAME:8443Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在右上角,单击仪表板设置图标,然后单击 用户管理。

在 Username 表中查找

admin用户,再单击 admin。- 在表标题 用户名 上方,单击编辑按钮。

输入新密码并确认密码再次输入并确认密码,然后单击 编辑用户。

您将注销并进入登录屏幕。这时将显示通知确认密码更改。

- 使用新密码重新登录。

其它资源

- 如需更多信息,请参阅 控制面板 指南中的使用 Ansible 更改仪表板密码。

2.8. 使用 Ansible 更改 Grafana 密码

默认情况下,Grafana 的密码由仪表板使用,设置为 admin。使用此流程更改密码。

为安全起见,请更改默认密码。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 对集群中的所有节点进行 root 访问权限。

流程

可选: 如果您不知道 Grafana 容器在其上运行哪些节点,请在 Ansible 主机文件中找到

[grafana-server]中列出的节点,通常位于/etc/ansible/hosts:示例

[grafana-server] grafana

[grafana-server] grafanaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在运行 Grafana 容器的节点上,更改密码:

语法

podman exec CONTAINER_ID grafana-cli admin reset-admin-password --homepath "/usr/share/grafana" NEW_PASSWORD

podman exec CONTAINER_ID grafana-cli admin reset-admin-password --homepath "/usr/share/grafana" NEW_PASSWORDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将 CONTAINER_ID 更改为 Grafana 容器的 ID。将 NEW_PASSWORD 更改为所需的 Grafana 密码。

示例

podman exec 3f28b0309aee grafana-cli admin reset-admin-password --homepath "/usr/share/grafana" NewSecurePassword

[root@grafana ~]# podman exec 3f28b0309aee grafana-cli admin reset-admin-password --homepath "/usr/share/grafana" NewSecurePassword t=2020-10-29T17:45:58+0000 lvl=info msg="Connecting to DB" logger=sqlstore dbtype=sqlite3 t=2020-10-29T17:45:58+0000 lvl=info msg="Starting DB migration" logger=migrator Admin password changed successfully ✔Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在 Ansible 管理节点上,使用

ansible-vault加密 Grafana 密码,然后将加密的密码添加到group_vars/all.yml中。进入

/usr/share/ceph-ansible/目录:cd /usr/share/ceph-ansible/

[admin@admin ~]$ cd /usr/share/ceph-ansible/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行

ansible-vault并创建新的 vault 密码:示例

ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault'

[admin@admin ceph-ansible]$ ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重新输入密码以确认它:

示例

ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault'

[admin@admin ceph-ansible]$ ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password: Confirm New Vault password:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入 Grafana 密码,按 Enter,然后输入 CTRL+D 以完成该条目:

语法

ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password: Confirm New Vault password: Reading plaintext input from stdin. (ctrl-d to end input) NEW_PASSWORD

ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password: Confirm New Vault password: Reading plaintext input from stdin. (ctrl-d to end input) NEW_PASSWORDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用之前设置的 Grafana 密码替换 NEW_PASSWORD。

示例

ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault'

[admin@admin ceph-ansible]$ ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password: Confirm New Vault password: Reading plaintext input from stdin. (ctrl-d to end input) NewSecurePasswordCopy to Clipboard Copied! Toggle word wrap Toggle overflow 记录开头为

grafana_admin_password_vault: !vault |且以几个数字结尾的输出,因为它将在下一步中使用:示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 打开以编辑

group_vars/all.yml,并将上方的输出粘贴到文件中:示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在加密的密码下方添加一行:

示例

grafana_admin_password: "{{ grafana_admin_password_vault }}"grafana_admin_password: "{{ grafana_admin_password_vault }}"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意由于 Ansible 中的一个错误会在将 vault 值直接分配给 Ansible 变量时中断字符串类型,因此需要使用上述两个变量。

- 保存并关闭该文件。

重新运行

ansible-playbook。对于基于容器的部署:

示例

ansible-playbook --ask-vault-pass -v site-container.yml -i hosts

[admin@node1 ceph-ansible]$ ansible-playbook --ask-vault-pass -v site-container.yml -i hostsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 请注意,只有使用

/etc/ansible/hosts的默认 Ansible 主机文件位置时才需要-i主机。对于裸机,基于 RPM 的部署:

示例

ansible-playbook --ask-vault-pass -v site.yml -i hosts

[admin@node1 ceph-ansible]$ ansible-playbook --ask-vault-pass -v site.yml -i hostsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 请注意,只有使用

/etc/ansible/hosts的默认 Ansible 主机文件位置时才需要-i主机。

2.9. 使用 Red Hat Single Sign-On 进行仪表板同步用户

管理员可以利用红帽具有轻量级目录访问协议(LDAP)的单点登录(SSO)提供对红帽 Ceph 存储仪表板上的用户访问。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 控制面板的管理员级别访问权限。

- 用户添加到仪表板中。

- 所有节点上的 root 级别访问。

- 从 ZIP 文件安装的红帽单点登录。如需更多信息,请参阅通过 zip 文件安装 Red Hat Single Sign-On。

流程

- 在安装了 Red Hat Ceph Storage 的系统中下载 Red Hat Single Sign-On 7.4.0 服务器。

解压文件夹:

unzip rhsso-7.4.0.zip

[root@cephuser]# unzip rhsso-7.4.0.zipCopy to Clipboard Copied! Toggle word wrap Toggle overflow 进入

standalone/configuration目录,打开standalone.xml进行编辑:cd standalone/configuration vi standalone.xml

[root@cephuser]# cd standalone/configuration [root@cephuser configuration]# vi standalone.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

使用安装了 Red Hat Single Sign-On 的机器的 IP 地址替换

localhost和127.0.0.1的两个实例。 可选:对于 Red Hat Enterprise Linux 8,用户可能会获得证书颁发机构(CA)问题。从 CA 导入自定义证书,并使用精确的 java 版本将其移动到密钥存储中。

示例

keytool -import -noprompt -trustcacerts -alias ca -file ../ca.cer -keystore /etc/java/java-1.8.0-openjdk/java-1.8.0-openjdk-1.8.0.272.b10-3.el8_3.x86_64/lib/security/cacert

[root@cephuser]# keytool -import -noprompt -trustcacerts -alias ca -file ../ca.cer -keystore /etc/java/java-1.8.0-openjdk/java-1.8.0-openjdk-1.8.0.272.b10-3.el8_3.x86_64/lib/security/cacertCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要从

rh-sso-7.4文件夹的bin目录启动服务器,请运行独立引导脚本:./standalone.sh

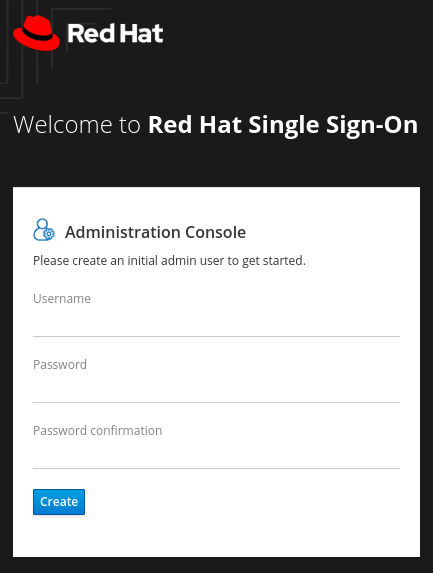

[root@cephuser bin]# ./standalone.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用用户名和密码在 http:_IP_ADDRESS_:8080/auth 中创建 admin 帐户:

注意admin 帐户必须在您第一次登录控制台时创建。

使用创建的凭证登录到 admin 控制台:

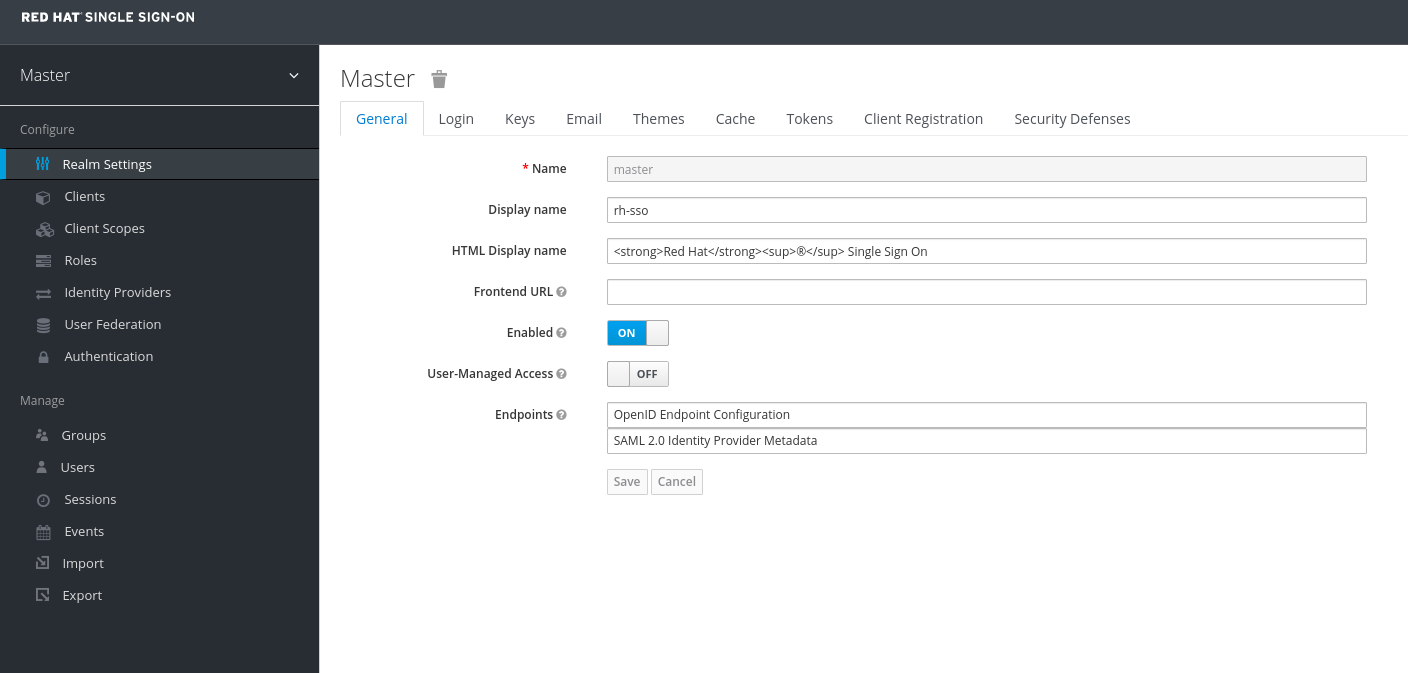

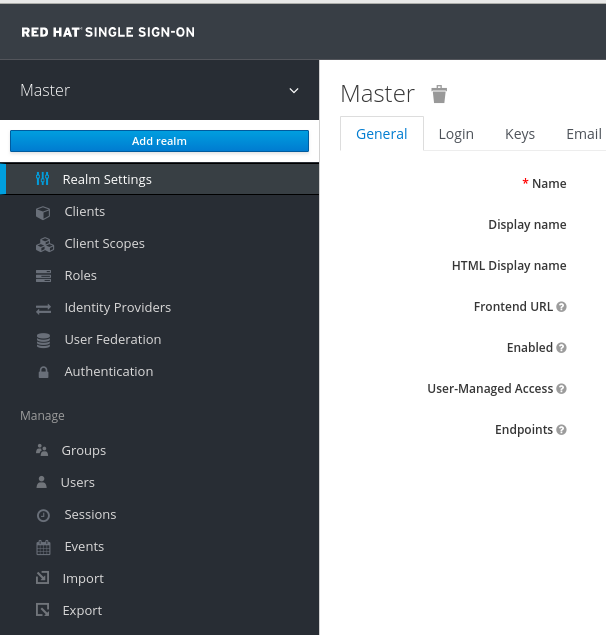

若要创建域,请单击 Master 下拉列表。在此域中,管理员提供对用户和应用的访问权限。

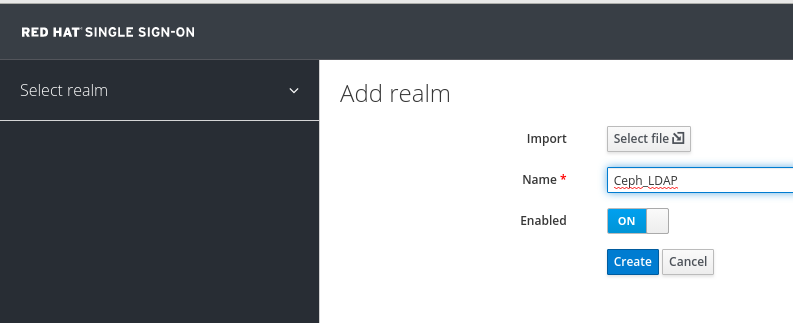

在 Add Realm 窗口中,输入 realm 的名称,并将 Enabled 参数设置为 ON,然后单击 Create:

注意realm 名称区分大小写。

在 Realm Settings 选项卡中,设置以下参数并点 Save:

- enabled - ON

- 用户管理的访问 - ON

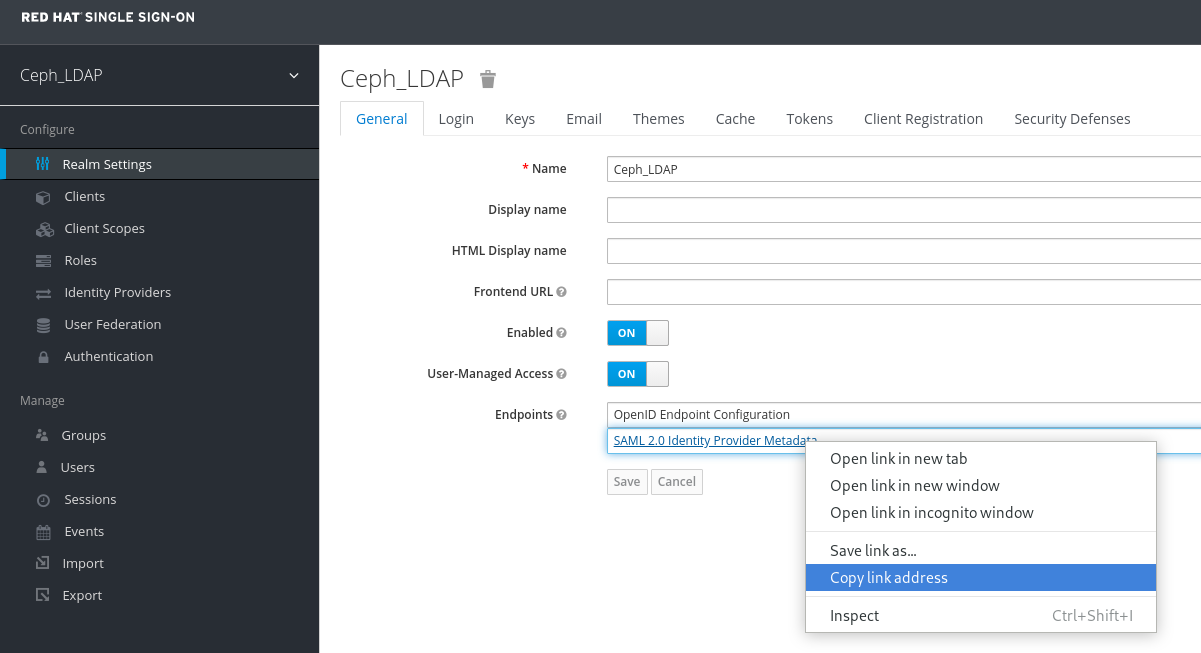

复制 SAML 2.0 身份提供程序元数据的链接地址

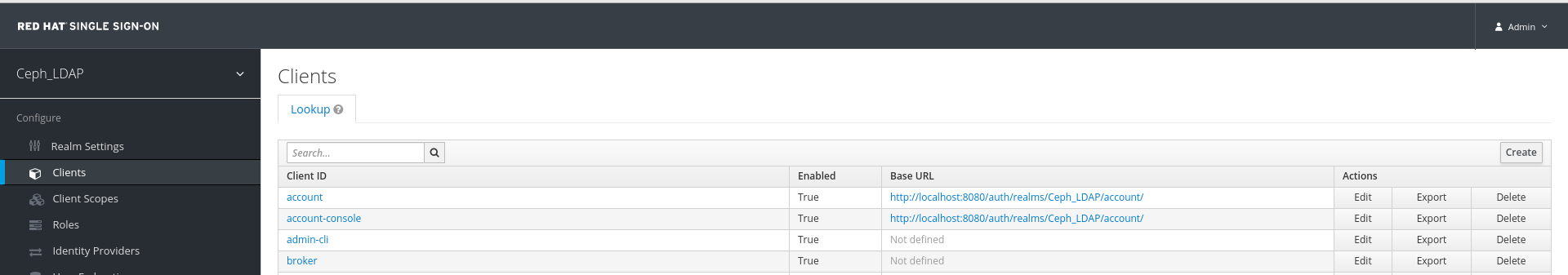

在 Clients 选项卡中,点 Create:

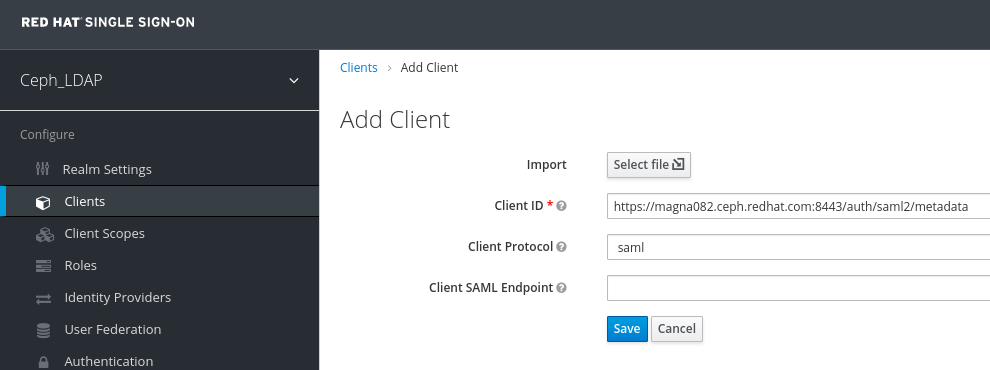

在 Add Client 窗口中设置以下参数并点 Save:

Client ID - BASE_URL:8443/auth/saml2/metadata

示例

https://magna082.ceph.redhat.com:8443/auth/saml2/metadata

客户端协议 - saml

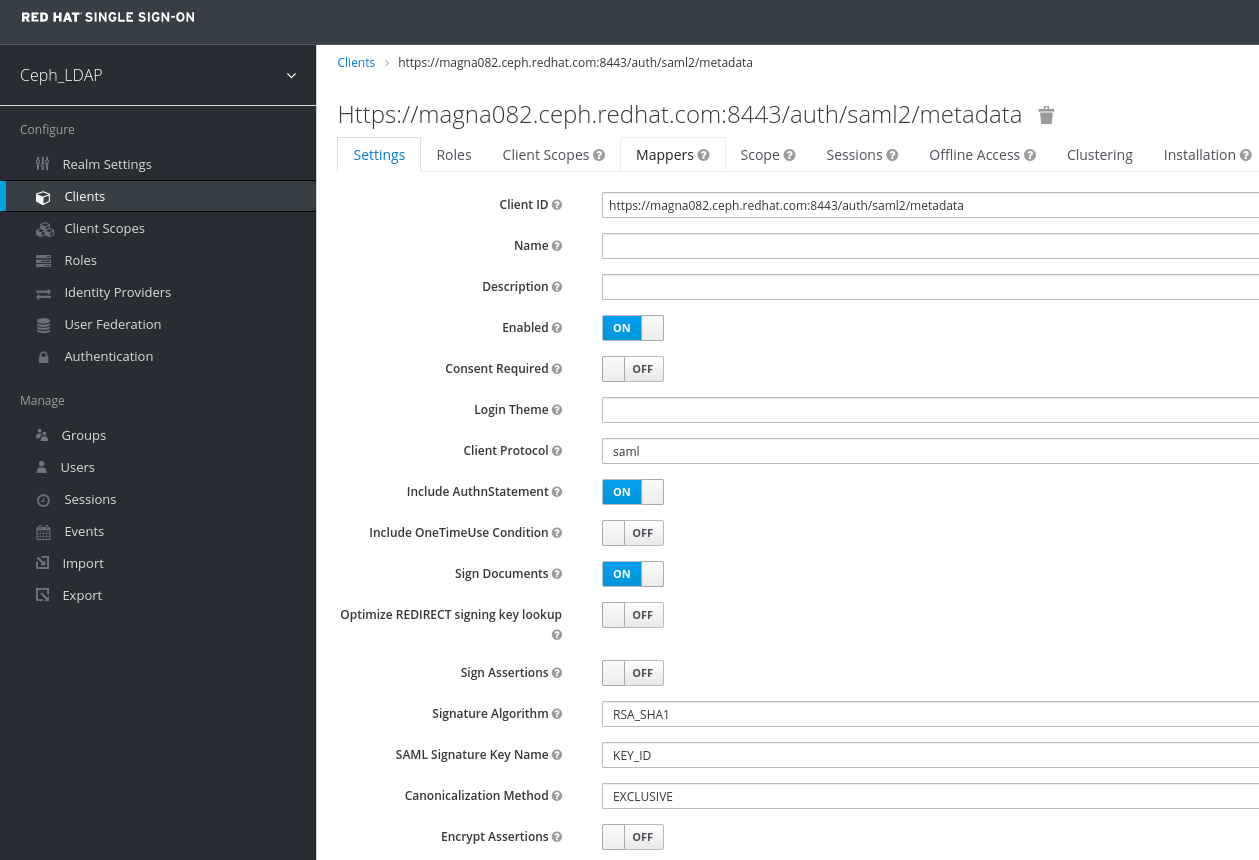

在 Clients 窗口的 Settings 选项卡中,设置以下参数并点 Save:

Client ID - BASE_URL:8443/auth/saml2/metadata

示例

https://magna082.ceph.redhat.com:8443/auth/saml2/metadata

- enabled - ON

- 客户端协议 - saml

- 包括 AuthnStatement - ON

- Sign Documents - ON

- Signature Algorithm - RSA_SHA1

- SAML Signature Key Name - KEY_ID

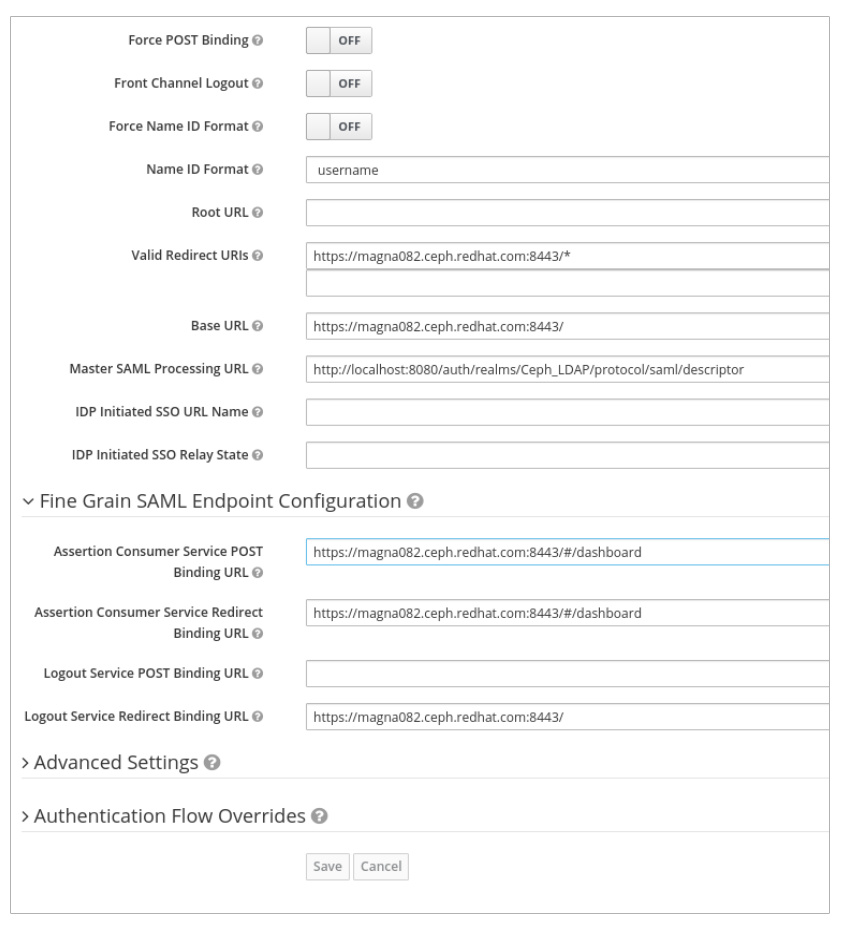

Valid Redirect URLs - BASE_URL:8443/*

示例

https://magna082.ceph.redhat.com:8443/*

Base URL - BASE_URL:8443

示例

https://magna082.ceph.redhat.com:8443/

Master SAML 处理 URL - http://localhost:8080/auth/realms/REALM_NAME/protocol/saml/descriptor

示例

http://localhost:8080/auth/realms/Ceph_LDAP/protocol/saml/descriptor

注意从 Realm Settings 选项卡中粘贴 SAML 2.0 身份提供程序元数据的链接。

在 Fine Grain SAML Endpoint Configuration 下,设置参数:

assertion Consumer Service POST Binding URL - BASE_URL:8443/#/dashboard

示例

https://magna082.ceph.redhat.com:8443/#/dashboard

assertion Consumer Service Redirect Binding URL - BASE_URL:8443/#/dashboard

示例

https://magna082.ceph.redhat.com:8443/#/dashboard

注销服务重定向绑定 URL - BASE_URL:8443/

示例

https://magna082.ceph.redhat.com:8443/

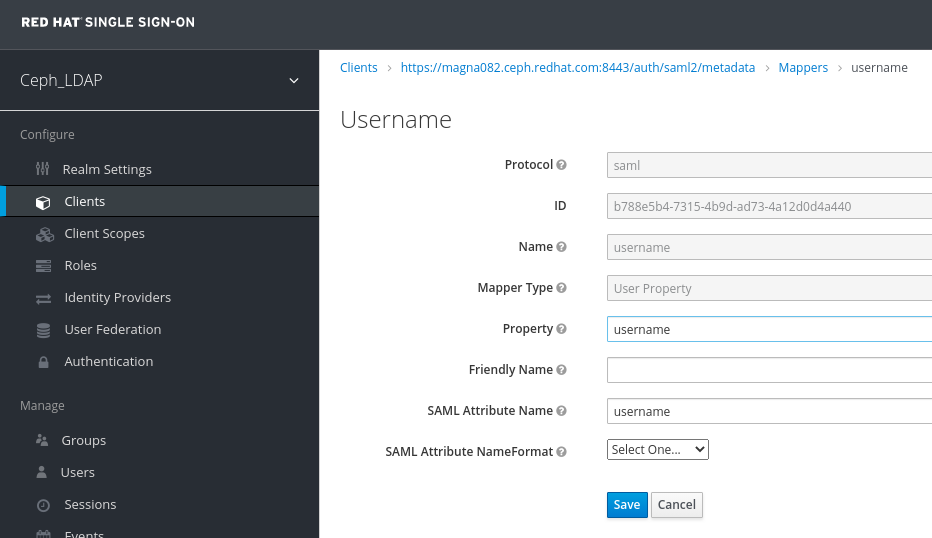

在 Clients 窗口的 Mappers 选项卡中,设置以下参数并点 Save:

- 协议 - saml

- name - username

- mapper Property - 用户属性

- 属性 - username

SAML 属性名称 - 用户名

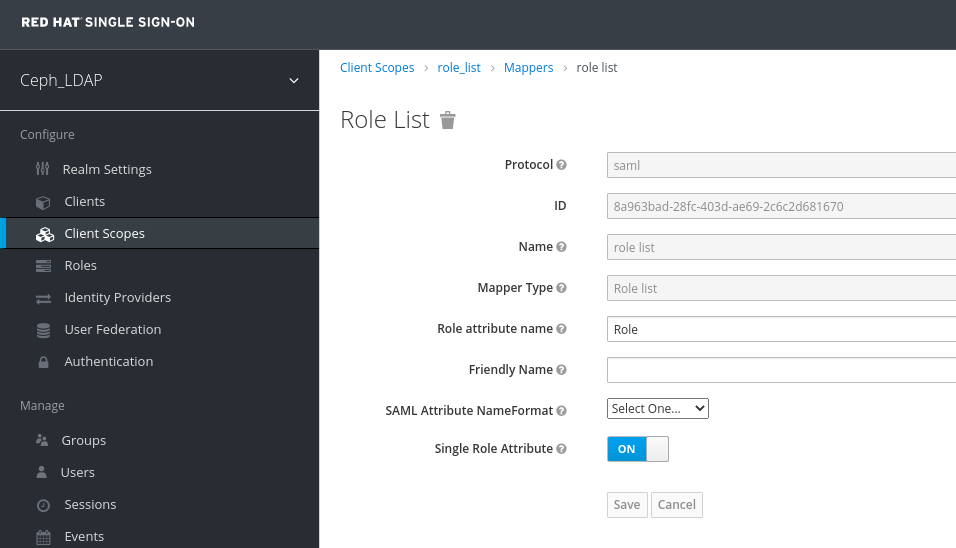

在 Clients Scope 选项卡中,选择 role_list :

在 Mappers 选项卡中,选择 角色列表,将 Single Role Attribute 设置为 ON。

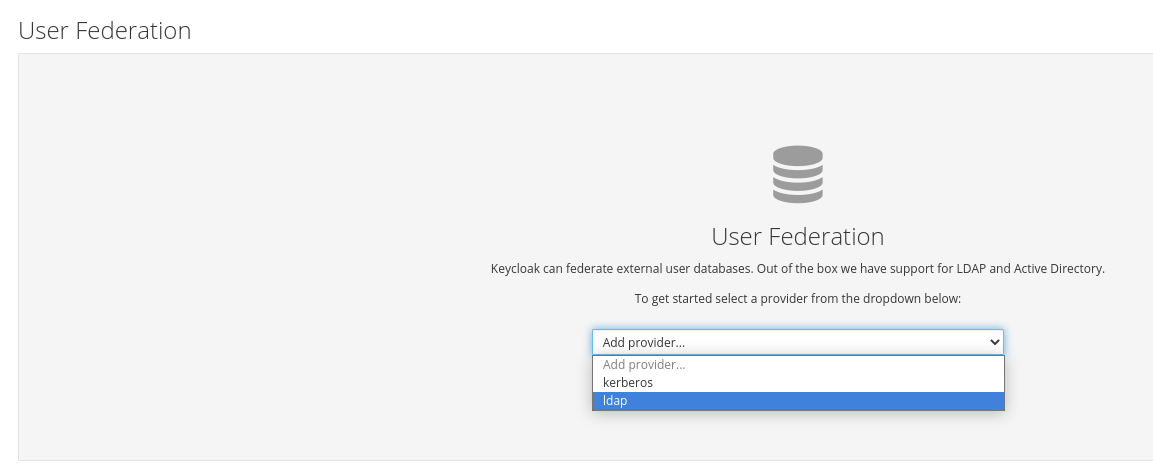

选择 User_Federation 选项卡:

在 User Federation 窗口中,从下拉菜单中选择 ldap :

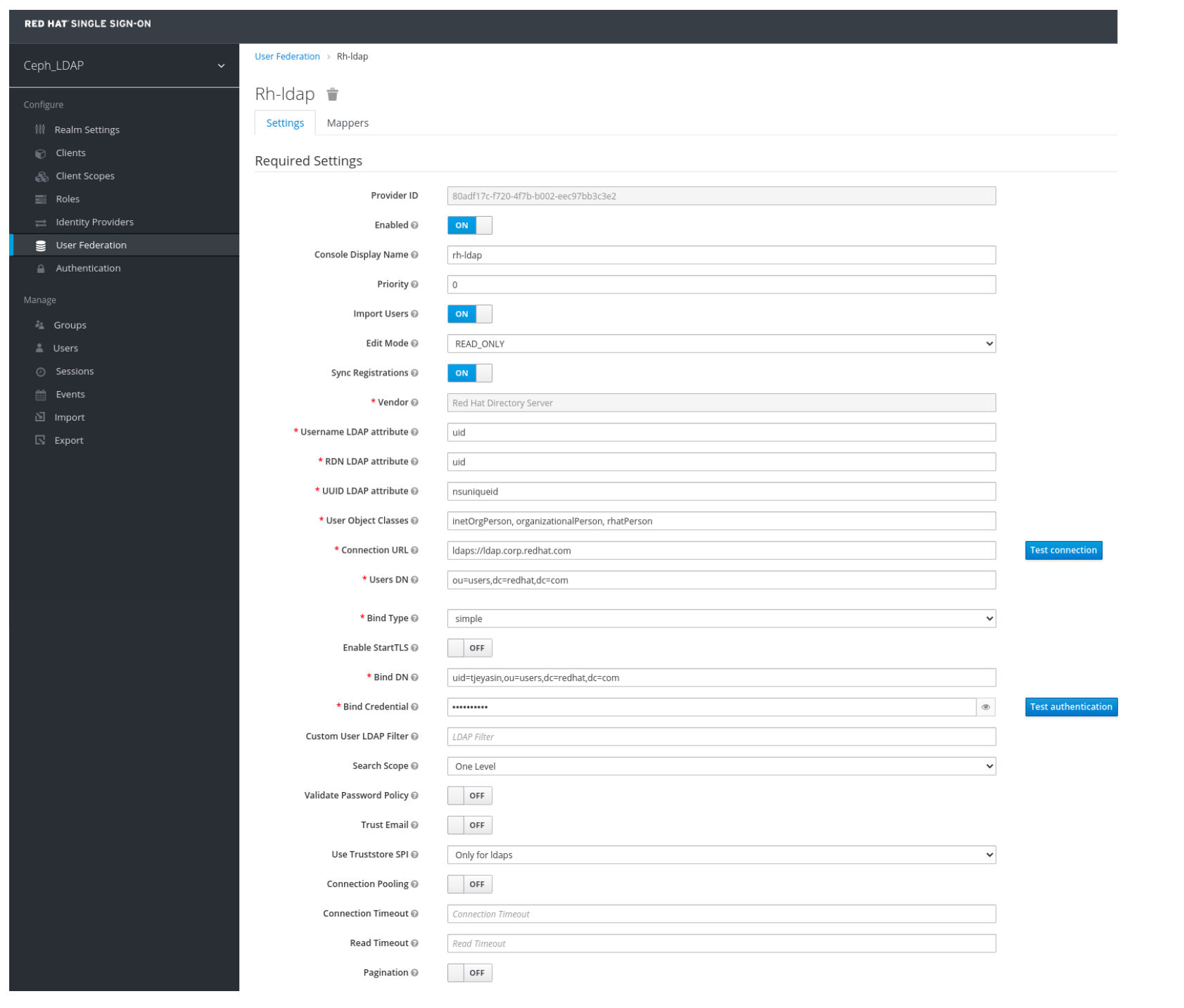

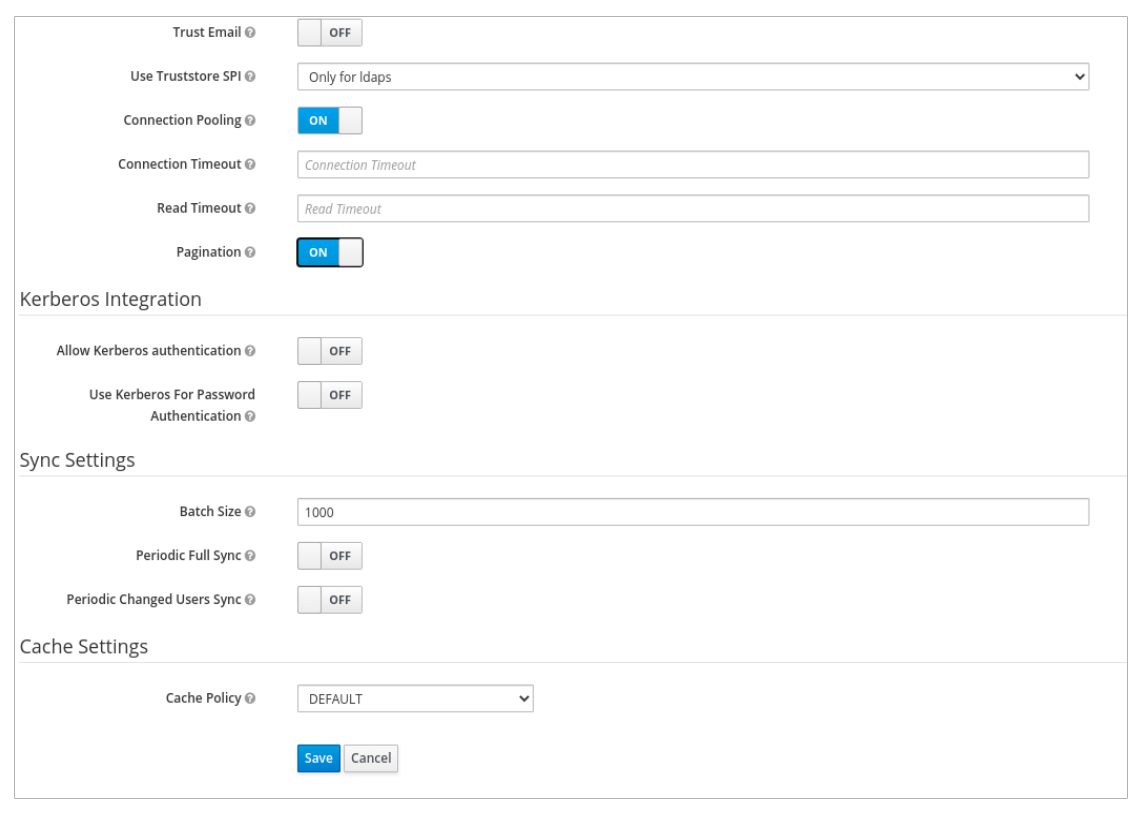

在 User_Federation 窗口中,Settings 选项卡设置以下参数并点 Save:

- 控制台显示名称 - rh-ldap

- 导入用户 - ON

- Edit_Mode - READ_ONLY

- 用户名 LDAP 属性 - username

- RDN LDAP 属性 - username

- UUID LDAP 属性 - nsuniqueid

- 用户对象类 - inetOrgPerson, organizationalPerson, rhatPerson

Connection URL - ldap:://myldap.example.com

示例

ldap://ldap.corp.redhat.com

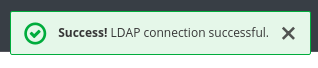

单击 Test Connection。

您将收到一个通知,即 LDAP 连接成功。

用户 DN - ou=users, dc=example, dc=com

示例

ou=users,dc=redhat,dc=com

bind Type - simple

单击 Test authentication。

您将收到通知 LDAP 身份验证成功。

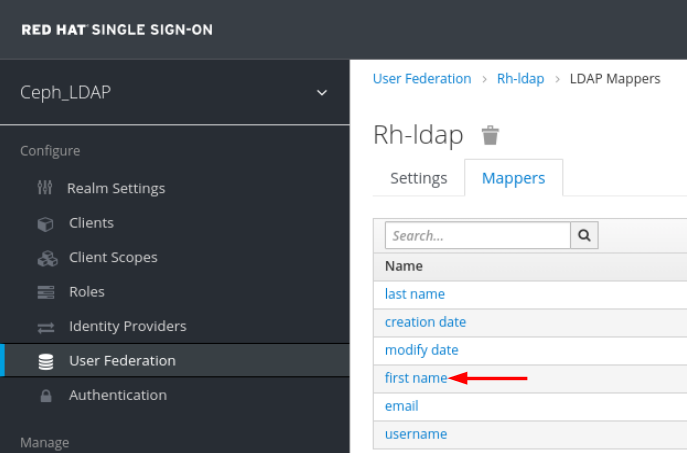

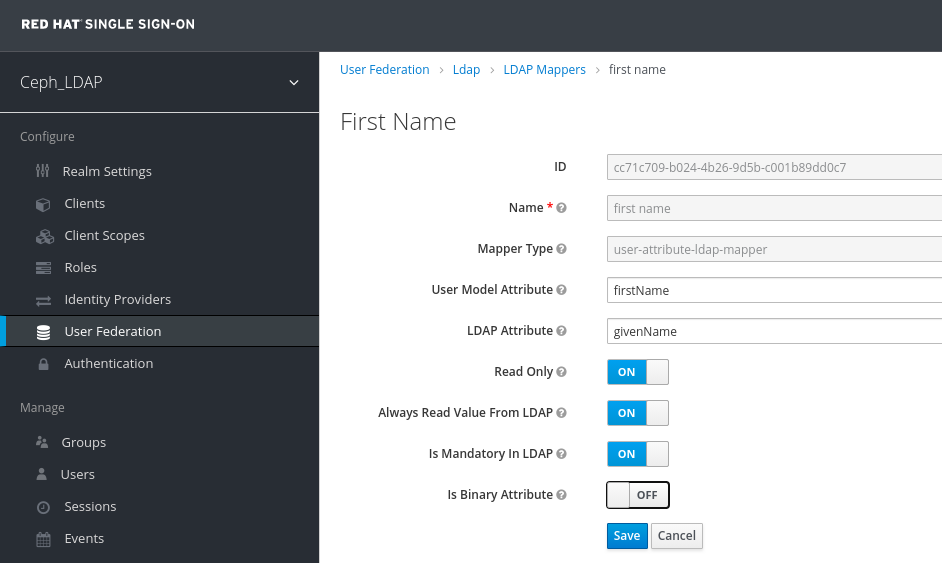

在 Mappers 选项卡中,选择 第一个名称 行并编辑以下参数,点 Save:

LDAP 属性 - givenName

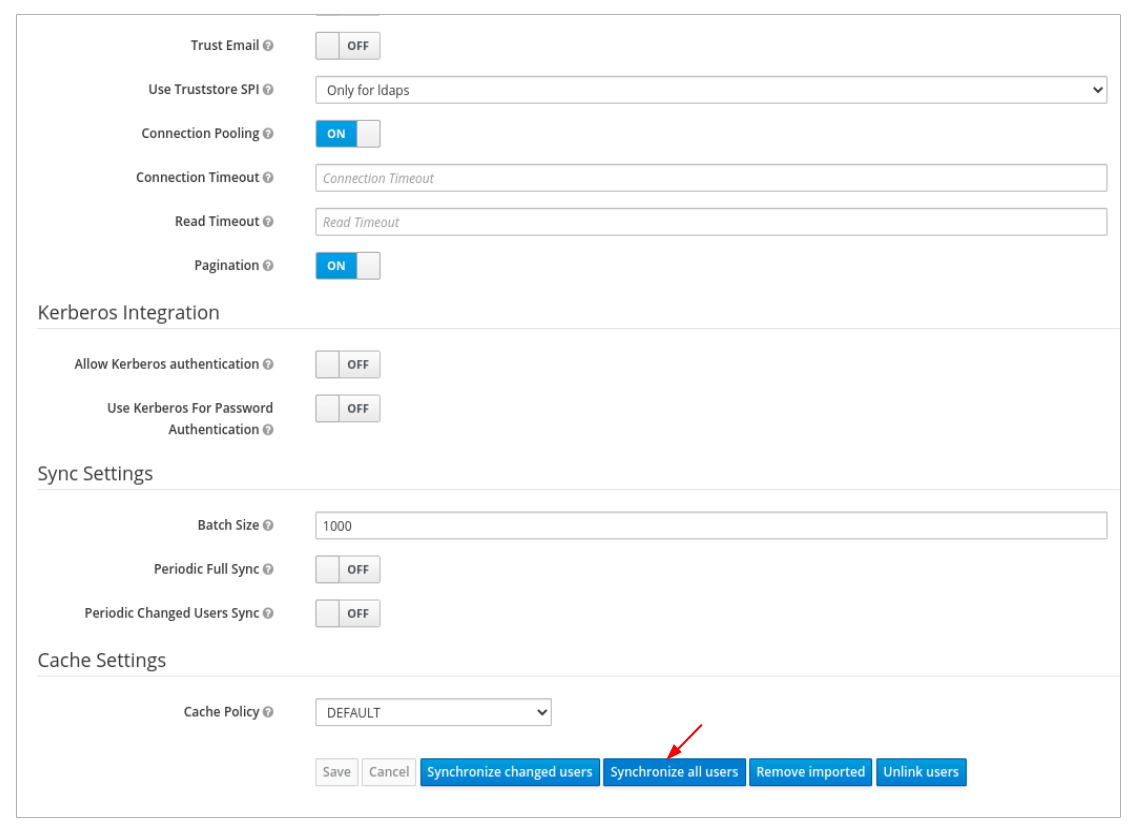

在 User_Federation 选项卡中,单击 Settings 选项卡,单击 Synchronize all users :

您将收到通知,通知用户同步被成功更新。

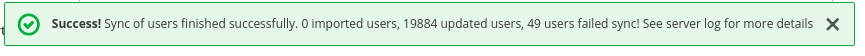

在 Users 选项卡中,搜索添加到仪表板中的用户并点击 Search 图标:

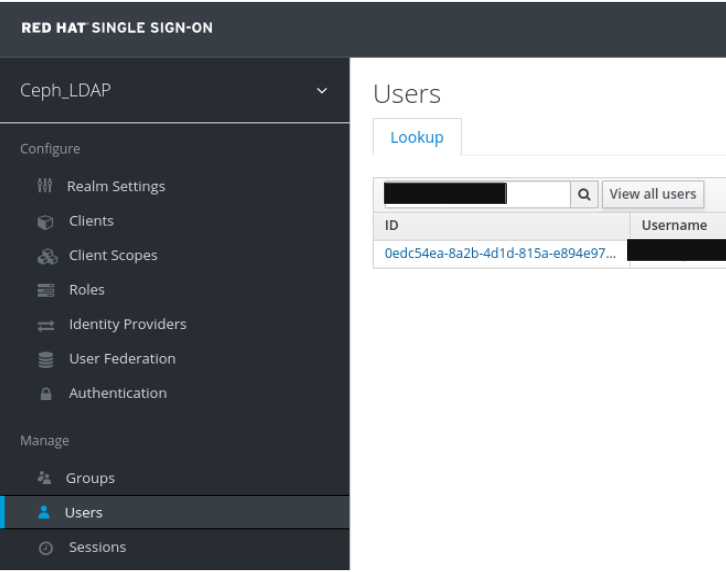

若要查看用户,请单击所在行。您应看到联合链接,作为提供给用户 Federation 的名称。

重要不要手动添加用户。如果手动添加,则点 Delete 来删除该用户。

添加到 realm 和控制面板的用户可以使用其电子邮件地址和密码访问 Ceph 控制面板。

示例

https://magna082.ceph.redhat.com:8443

2.10. 为 Ceph 控制面板启用单点登录

Ceph 控制面板支持外部身份验证具有安全断言标记语言(SAML)协议的用户。在使用 Ceph 控制面板的单点登录(SSO)之前,先创建控制面板用户帐户并分配所需的角色。Ceph 控制面板对用户执行授权,身份验证过程由现有的身份提供程序(IdP)执行。红帽使用 Keycloak 测试仪表板 SSO 功能。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 安装 Ceph 控制面板软件。

- 启动控制面板。

- Ceph 管理器节点的 root 级别访问。

在 Ceph 管理器节点上安装以下库软件包:

-

python3-saml -

python3-defusedxml -

python3-isodate -

python3-xmlsec

-

流程

要在 Ceph 控制面板中配置 SSO,请运行以下命令:

裸机部署:

语法

ceph dashboard sso setup saml2 CEPH_DASHBOARD_BASE_URL IDP_METADATA IDP_USERNAME_ATTRIBUTE IDP_ENTITY_ID SP_X_509_CERT SP_PRIVATE_KEY

ceph dashboard sso setup saml2 CEPH_DASHBOARD_BASE_URL IDP_METADATA IDP_USERNAME_ATTRIBUTE IDP_ENTITY_ID SP_X_509_CERT SP_PRIVATE_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

ceph dashboard sso setup saml2 http://dashboard_hostname.ceph.redhat.com:8443 idp-metadata.xml username http://10.70.59.125:8080/auth/realms/realm_name /home/certificate.txt /home/private-key.txt

[root@mon ~]# ceph dashboard sso setup saml2 http://dashboard_hostname.ceph.redhat.com:8443 idp-metadata.xml username http://10.70.59.125:8080/auth/realms/realm_name /home/certificate.txt /home/private-key.txtCopy to Clipboard Copied! Toggle word wrap Toggle overflow 容器部署:

语法

podman exec CEPH_MGR_NODE ceph dashboard sso setup saml2 CEPH_DASHBOARD_BASE_URL IDP_METADATA IDP_USERNAME_ATTRIBUTE IDP_ENTITY_ID SP_X_509_CERT SP_PRIVATE_KEY

podman exec CEPH_MGR_NODE ceph dashboard sso setup saml2 CEPH_DASHBOARD_BASE_URL IDP_METADATA IDP_USERNAME_ATTRIBUTE IDP_ENTITY_ID SP_X_509_CERT SP_PRIVATE_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

podman exec ceph-mgr-hostname ceph dashboard sso setup saml2 http://dashboard_hostname.ceph.redhat.com:8443 idp-metadata.xml username http://10.70.59.125:8080/auth/realms/realm_name /home/certificate.txt /home/private-key.txt

[root@mon ~]# podman exec ceph-mgr-hostname ceph dashboard sso setup saml2 http://dashboard_hostname.ceph.redhat.com:8443 idp-metadata.xml username http://10.70.59.125:8080/auth/realms/realm_name /home/certificate.txt /home/private-key.txtCopy to Clipboard Copied! Toggle word wrap Toggle overflow

替换

-

CEPH_MGR_NODE 与 Ceph

mgr节点.例如:ceph-mgr-hostname - CEPH_DASHBOARD_BASE_URL 带有可以访问 Ceph 仪表板的基本 URL。

- IDP_METADATA,带有指向远程或 IdP 元数据 XML 的本地路径或内容的 URL。支持的 URL 类型有 http、https 和 文件。

- 可选 :IDP_USERNAME_ATTRIBUTE 以及用于从身份验证响应中获取用户名的属性。默认为 uid。

- 可选 :当 IdP 元数据中存在多个实体 ID 时,使用 IdP 实体 ID 的 IDP_ENTITY_ID。

- 可选 :SP_X_509_CERT 带有 Ceph Dashboard 用于签名和加密的证书文件路径。

- 可选 :SP_PRIVATE_KEY 带有 Ceph 仪表板用于签名和加密的私钥的文件路径。

验证当前的 SAML 2.0 配置:

裸机部署:

语法

ceph dashboard sso show saml2

ceph dashboard sso show saml2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 容器部署:

语法

podman exec CEPH_MGR_NODE ceph dashboard sso show saml2

podman exec CEPH_MGR_NODE ceph dashboard sso show saml2Copy to Clipboard Copied! Toggle word wrap Toggle overflow

要启用 SSO,请运行以下命令:

裸机部署:

语法

ceph dashboard sso enable saml2 SSO is "enabled" with "SAML2" protocol.

ceph dashboard sso enable saml2 SSO is "enabled" with "SAML2" protocol.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 容器部署:

语法

podman exec CEPH_MGR_NODE ceph dashboard sso enable saml2 SSO is "enabled" with "SAML2" protocol.

podman exec CEPH_MGR_NODE ceph dashboard sso enable saml2 SSO is "enabled" with "SAML2" protocol.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

打开仪表板 URL。例如:

http://dashboard_hostname.ceph.redhat.com:8443

http://dashboard_hostname.ceph.redhat.com:8443Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 在 SSO 页面中,输入登录凭据。SSO 会重定向到仪表板 Web 界面。

其它资源

- 要禁用单点登录,请参阅 Red Hat Ceph StorageDashboard 指南中的禁用 Ceph仪表板的单点登录 。

2.11. 为 Ceph 控制面板禁用单点登录

您可以为 Ceph 控制面板禁用单点登录。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 安装 Ceph 控制面板软件。

- 启动控制面板。

- Ceph 管理器节点的 root 级别访问。

- 为 Ceph 控制面板启用单点登录

在 Ceph 管理器节点上安装以下库软件包:

-

python3-saml -

python3-defusedxml -

python3-isodate -

python3-xmlsec

-

流程

要查看 SSO 的状态,请运行以下命令:

裸机部署:

语法

ceph dashboard sso status SSO is "enabled" with "SAML2" protocol.

ceph dashboard sso status SSO is "enabled" with "SAML2" protocol.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 容器部署:

语法

podman exec CEPH_MGR_NODE ceph dashboard sso status SSO is "enabled" with "SAML2" protocol.

podman exec CEPH_MGR_NODE ceph dashboard sso status SSO is "enabled" with "SAML2" protocol.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 替换

-

CEPH_MGR_NODE 与 Ceph

mgr节点.例如:ceph-mgr-hostname

-

CEPH_MGR_NODE 与 Ceph

要禁用 SSO,请运行以下命令:

裸机部署:

语法

ceph dashboard sso disable SSO is "disabled".

ceph dashboard sso disable SSO is "disabled".Copy to Clipboard Copied! Toggle word wrap Toggle overflow 容器部署:

语法

podman exec CEPH_MGR_NODE ceph dashboard sso disable SSO is "disabled".

podman exec CEPH_MGR_NODE ceph dashboard sso disable SSO is "disabled".Copy to Clipboard Copied! Toggle word wrap Toggle overflow 替换

-

CEPH_MGR_NODE 与 Ceph

mgr节点.例如:ceph-mgr-hostname

-

CEPH_MGR_NODE 与 Ceph

其它资源

- 要启用单点登录,请参阅 Red Hat Ceph StorageDashboard Guide中为 Ceph 控制面板启用单点登录 。

第 3 章 在仪表板上管理角色

作为存储管理员,您可以在仪表板上创建、查看、编辑和删除角色。您可以为角色授予权限,您可以为用户分配特定的角色。

3.1. 在仪表板上创建角色

通过控制面板,您可以在控制面板上创建可分配给用户的角色。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 控制面板的管理员访问权限级别。

流程

- 登录到仪表板。

在 Dashboard 的右上角点击 gear 图标并选择 User Management :

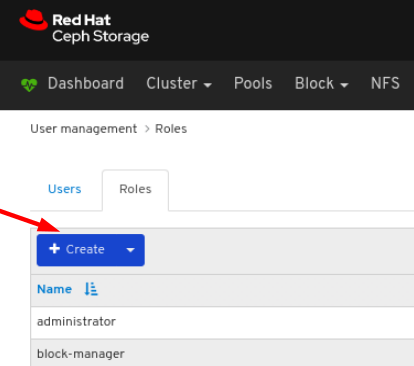

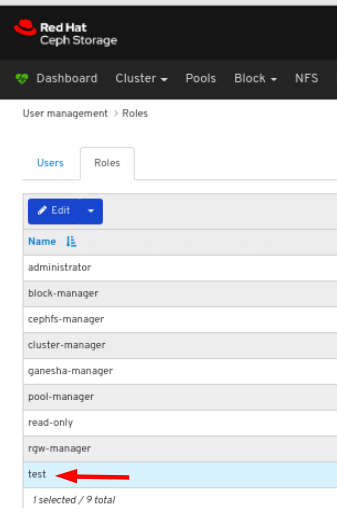

在角色 选项卡上,点 Create 按钮:

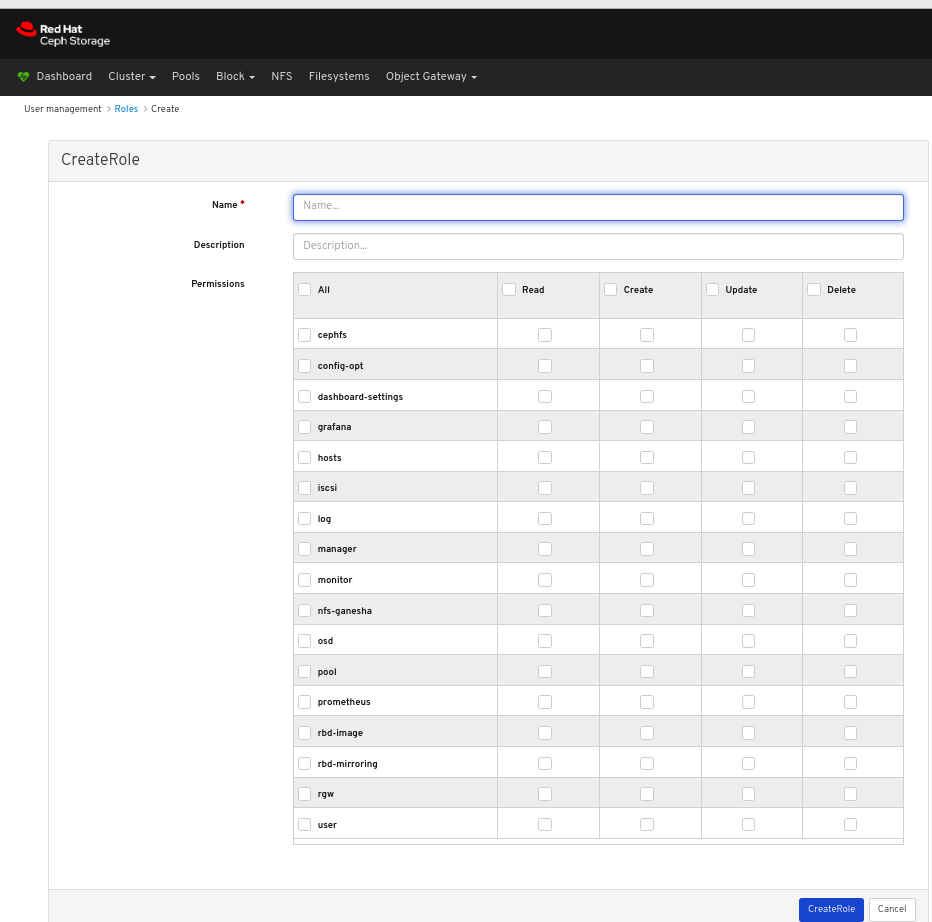

在 CreateRole 窗口中,设置 Name 并选择此角色的权限,然后单击 CreateRole 按钮:

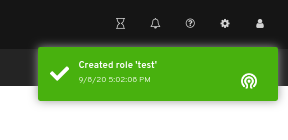

对页面右上角发出的通知表示角色已创建成功。

3.2. 查看仪表板的角色

通过控制面板,您可以查看控制面板上角色的详细信息。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 控制面板的管理员访问权限级别。

- 角色在控制面板上创建。

流程

- 登录到仪表板。

在 Dashboard 的右上角点击 gear 图标并选择 User Management :

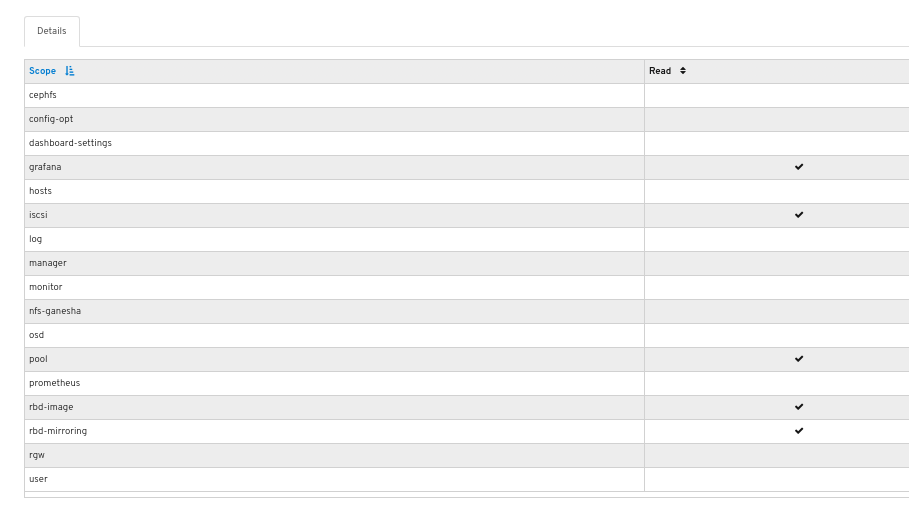

要查看角色详情,请点击行:

您可以查看为角色提供的权限详情。

其它资源

- 如需了解更多详细信息,请参阅 Red Hat Ceph Storage 仪表板指南中的 创建角色部分。 https://access.redhat.com/documentation/en-us/red_hat_ceph_storage/4/html-single/dashboard_guide/#creating-roles-on-dashboard_dash

3.3. 编辑仪表板中的角色

通过控制面板,您可以编辑控制面板的角色。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 控制面板的管理员访问权限级别。

- 在控制面板上创建一个角色。

流程

- 登录到仪表板。

在 Dashboard 的右上角点击 gear 图标并选择 User Management :

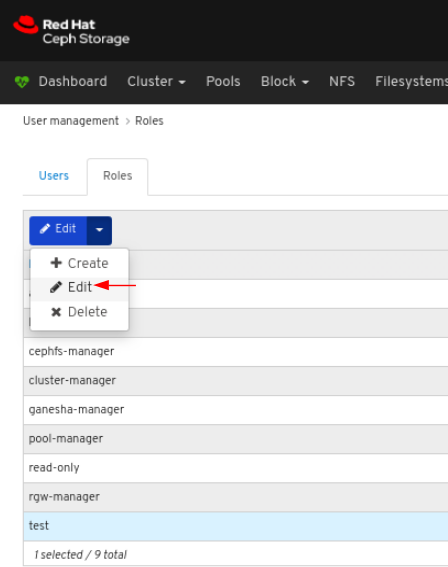

要编辑角色,请点击行:

在角色 选项卡上,从 编辑 下拉菜单中选择 Edit :

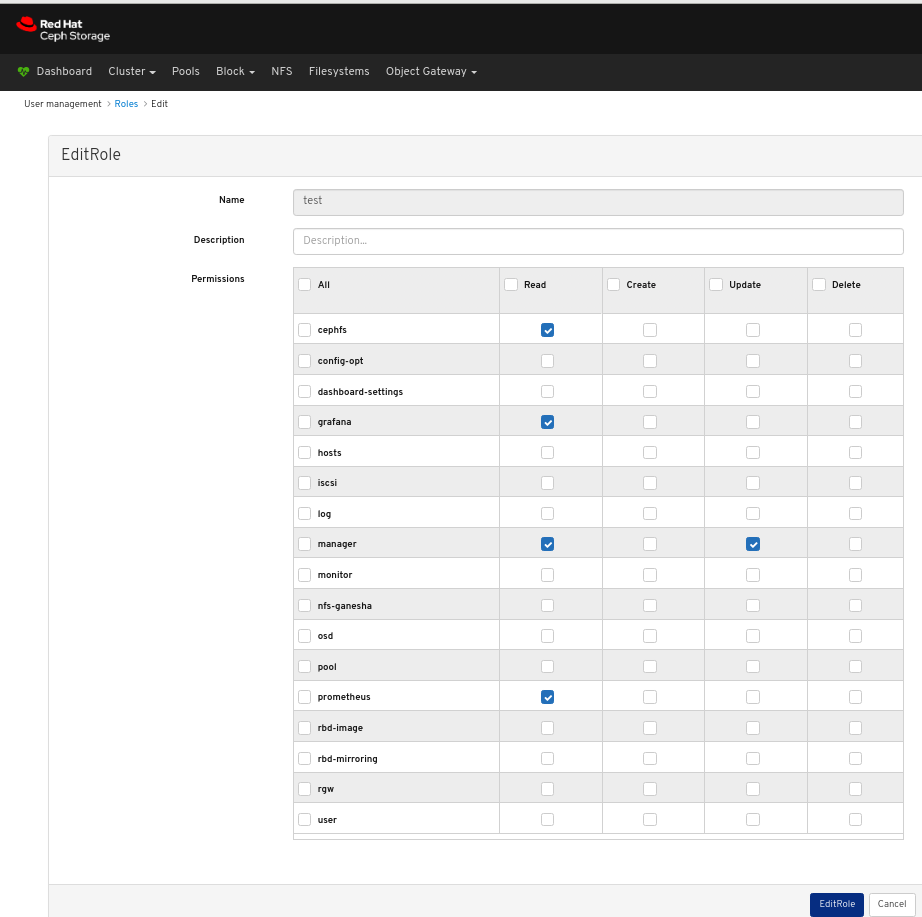

在 EditRole 窗口中,编辑包括的参数,然后单击 EditRole 按钮:

对页面右上角的通知表示角色已被成功更新。

其它资源

- 如需了解更多详细信息,请参阅 Red Hat Ceph Storage 仪表板指南中的 创建角色部分。 https://access.redhat.com/documentation/en-us/red_hat_ceph_storage/4/html-single/dashboard_guide/#creating-roles-on-dashboard_dash

3.4. 删除仪表板中的角色

通过控制面板,您可以删除仪表板上的角色。

您只能删除您创建的角色。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 控制面板的管理员访问权限级别。

- 在控制面板上创建一个角色。

流程

- 登录到仪表板。

在 Dashboard 的右上角点击 gear 图标并选择 User Management :

要删除角色,请点击行:

在角色 选项卡上 , 从 编辑 下拉菜单中选择删除:

在 Delete Role 对话框窗口中,单击 Yes,我确定 框,然后单击 Delete Role 以保存设置:

其它资源

- 如需了解更多详细信息,请参阅 Red Hat Ceph Storage 仪表板指南中的 创建角色部分。 https://access.redhat.com/documentation/en-us/red_hat_ceph_storage/4/html-single/dashboard_guide/#creating-roles-on-dashboard_dash

第 4 章 在仪表板上管理用户

作为存储管理员,您可以在仪表板上创建、编辑和删除用户。

4.1. 在仪表板中创建用户

通过控制面板,可以在控制面板中创建用户。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 控制面板的管理员访问权限级别。

Red Hat Ceph Storage Dashboard 在更改用户密码时不支持任何电子邮件验证。此行为是有意设计的,因为控制面板支持单点登录(SSO),并且此功能可以委派给 SSO 提供程序。

流程

- 登录到仪表板。

在 Dashboard 的右上角点击 gear 图标并选择 User Management :

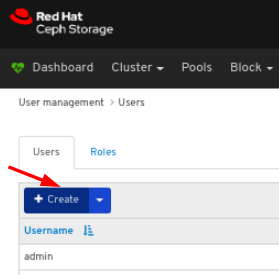

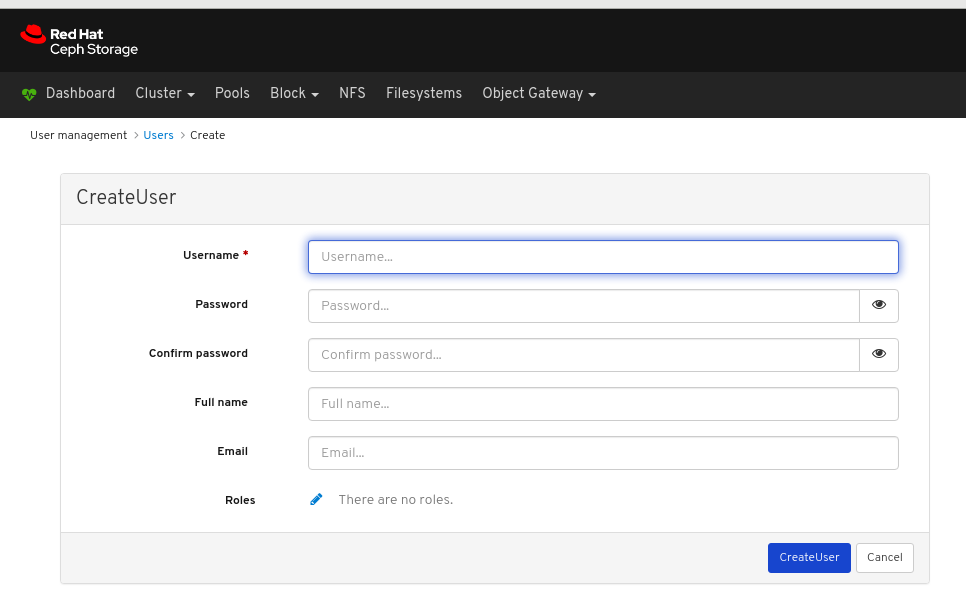

在 Users 选项卡中,点 Create 按钮:

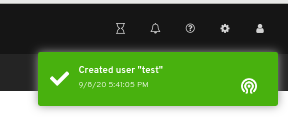

在 CreateUser 窗口中,设置 Username 和 other 参数,包括角色,然后单击 _CreateUser_button:

对页面右上角的通知表示用户已成功创建。

其它资源

- 如需了解更多详细信息,请参阅 Red Hat Ceph Storage Dashboard 指南中的 创建角色部分。 https://access.redhat.com/documentation/en-us/red_hat_ceph_storage/4/html-single/dashboard_guide/#creating-roles-on-dashboard_dash

4.2. 在仪表板中编辑用户

通过控制面板,您可以编辑控制面板上的用户。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 控制面板的管理员访问权限级别。

- 在控制面板上创建的用户。

流程

- 登录到仪表板。

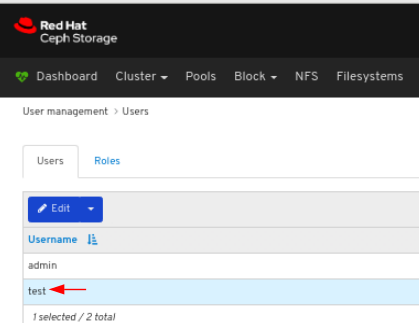

在 Dashboard 的右上角点击 gear 图标并选择 User Management :

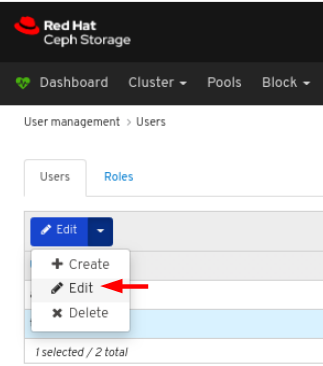

要编辑用户,请点击行:

在 Users 选项卡中,从 编辑下拉菜单中选择 Edit :

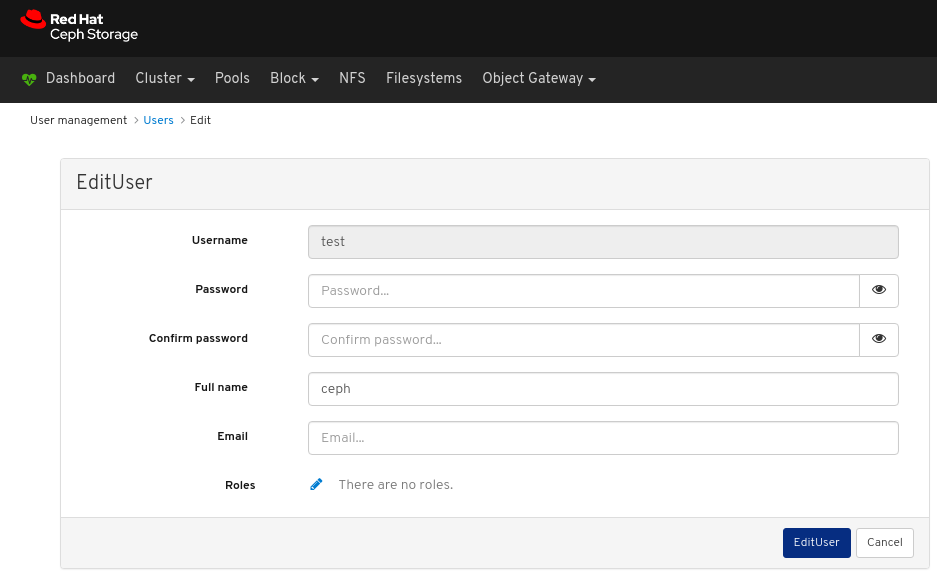

在 EditUser 窗口中,编辑包括的参数,然后单击 EditUser 按钮:

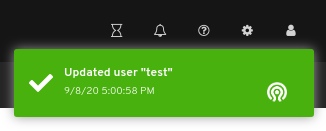

对页面右上角的通知表示用户已被成功更新。

其它资源

- 如需了解更多详细信息,请参阅 Red Hat Ceph Storage 仪表板指南中的 在仪表板中创建用户。

4.3. 删除仪表板上的用户

通过控制面板,您可以删除仪表板上的用户。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 控制面板的管理员访问权限级别。

- 在控制面板上创建的用户。

流程

- 登录到仪表板。

在 Dashboard 的右上角点击 gear 图标并选择 User Management :

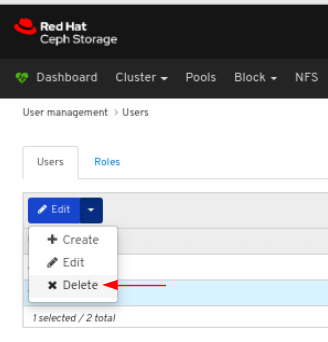

要删除用户,请点击行:

在 Users 选项卡中 , 从 编辑 下拉菜单中选择删除:

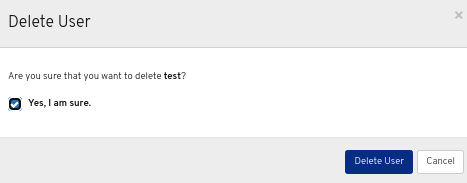

在 Delete User 对话框中,点击 Yes,我确定 框,然后单击 Delete user 以保存设置:

其它资源

- 如需了解更多详细信息,请参阅 Red Hat Ceph Storage 仪表板指南中的 在仪表板中创建用户。

第 5 章 监控集群

仪表板的监控功能会定期提供不同的网页来指示存储集群的各个方面。您可以使用登录页面监控集群的整体状态,也可以监控集群的特定功能,如块设备镜像的状态。

其它资源

- 如需更多信息,请参阅 控制面板指南中的 访问登录页面。

- 如需更多信息,请参阅 Dashboard 指南中的 了解登录页面。

- 如需更多信息,请参阅 控制面板 指南中的 监控特定功能。

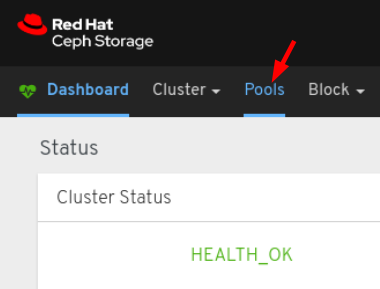

5.1. 访问登录页面

登录控制面板后,将加载登录页面。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

流程

登录到仪表板:

登录仪表板后,将加载登录页面:

要在查看其他仪表板页面后返回到登录页面,请点击页面左上角的 Dashboard :

其它资源

- 如需更多信息,请参阅 Dashboard 指南中的 了解登录页面。

- 如需更多信息,请参阅 控制面板 指南中的 监控特定功能。

5.2. 了解登录页面

登录页面使用各个面板显示整个 Ceph 集群的概览。每个面板都显示有关集群状态的具体信息。

类别

登录页将面板分为以下三种类别:

- Status

- 容量

- 性能

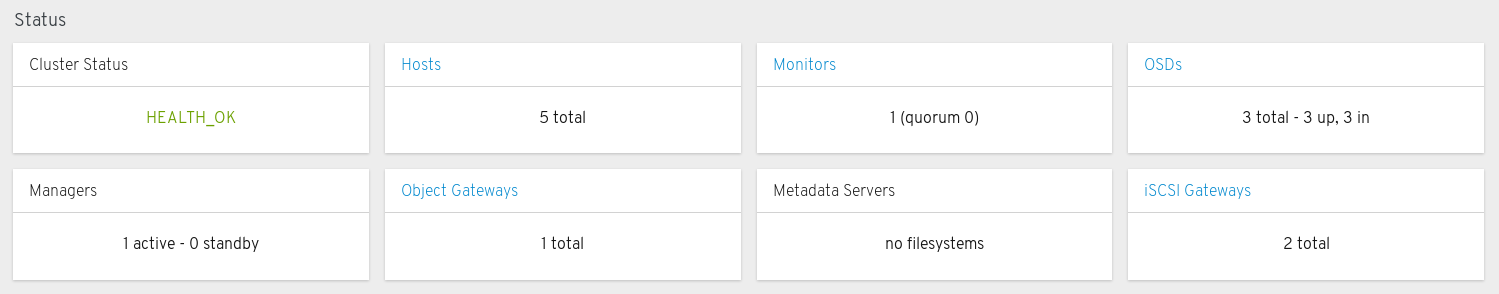

状态面板

状态面板中显示集群和主机和守护进程状态的健康状态。

集群状态 :显示 Ceph 集群的当前健康状况。

主机 :显示 Ceph 存储集群中的主机总数。

monitor :显示 Ceph 监视器的数量和仲裁状态。

OSD :显示 Ceph 存储集群中的 OSD 总数,以及状态为 up, 和 in 的数量。

管理器 :显示管理器守护进程的数量和状态。

对象网关 :显示 Ceph 存储集群中的对象网关数。

元数据服务器 :显示 Ceph 文件系统元数据服务器的数量和状态。

iSCSI 网关 :显示 Ceph 存储集群中的 iSCSI 网关的数量。

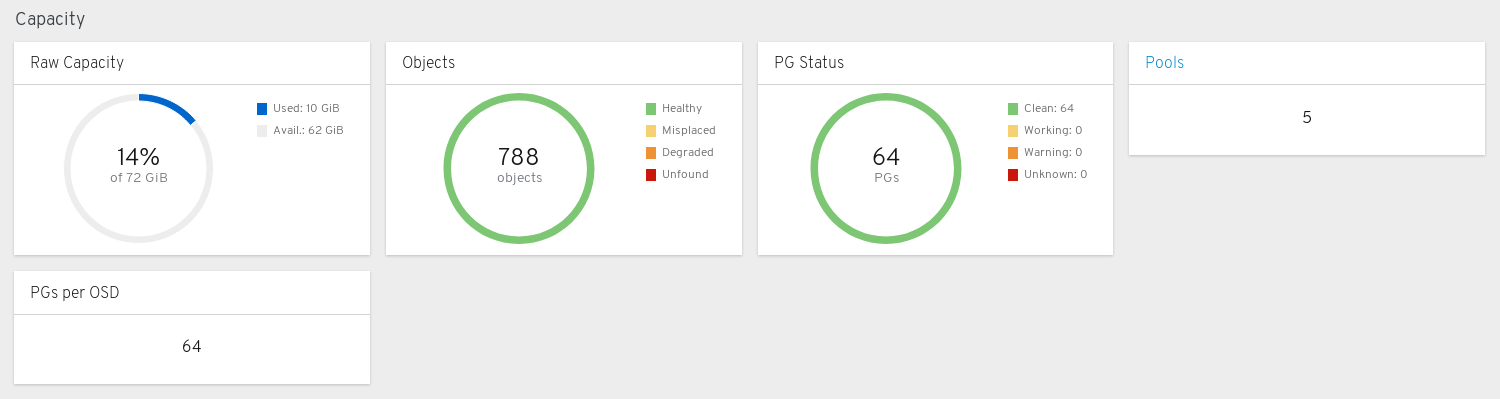

容量面板

容量面板显示存储使用指标。

Raw 容量 :显示集群原始存储容量的利用率和可用性。

对象 :显示池中对象总数,并在 Healthy、Misplaced、Degraded 或 Unfound 中显示对象。

PG Status :显示放置组的总数,并将 PG 划分为 Clean、Working、Warning 或 Unknown 状态。若要简化 PG 状态 Working 和 Warning 的显示,实际上每个包含多个状态。

工作状态 包括具有任何这些状态的 PG:

- 激活

- backfill_wait

- backfilling

- 创建

- deep

- degraded

- forced_backfill

- forced_recovery

- peering

- peered

- 恢复

- recovery_wait

- 修复

- 清理

- snaptrim

- snaptrim_wait

Warning 状态包含具有任何这些状态的 PG:

- backfill_toofull

- backfill_unfound

- down

- 不完整

- 不一致

- recovery_toofull

- recovery_unfound

- remapped

- snaptrim_error

- 过时

- undersized(Osized)

池 :显示 Ceph 集群中的存储池数量。

每个 OSD 的 PG 数量:显示每个 OSD 的 PG 数量。

性能面板

性能面板显示与数据传输速度相关的信息。

客户端读取/写 :显示每秒输入/输出解读、每秒读取数每秒的读取数,每秒写入数。

客户端吞吐量 :显示客户端吞吐量、读取吞吐量和写入吞吐量。

恢复吞吐量 :显示客户端恢复率。

清理 :显示 Ceph 是否清理数据,以验证其完整性。

其它资源

- 如需更多信息,请参阅 控制面板指南中的 访问登录页面。

- 如需更多信息,请参阅 控制面板 指南中的 监控特定功能。

第 6 章 监控特定功能

作为存储管理员,您可以使用 Red Hat Ceph Storage 控制面板根据主机、服务、数据访问方式等来监控集群的特定方面。

6.1. 监控监控器

Red Hat Ceph Storage 控制面板可以查看有关 monitor 节点的各种详细信息。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

流程

- 登录到仪表板。

- 在导航栏中,单击 Cluster,然后单击 Monitors。

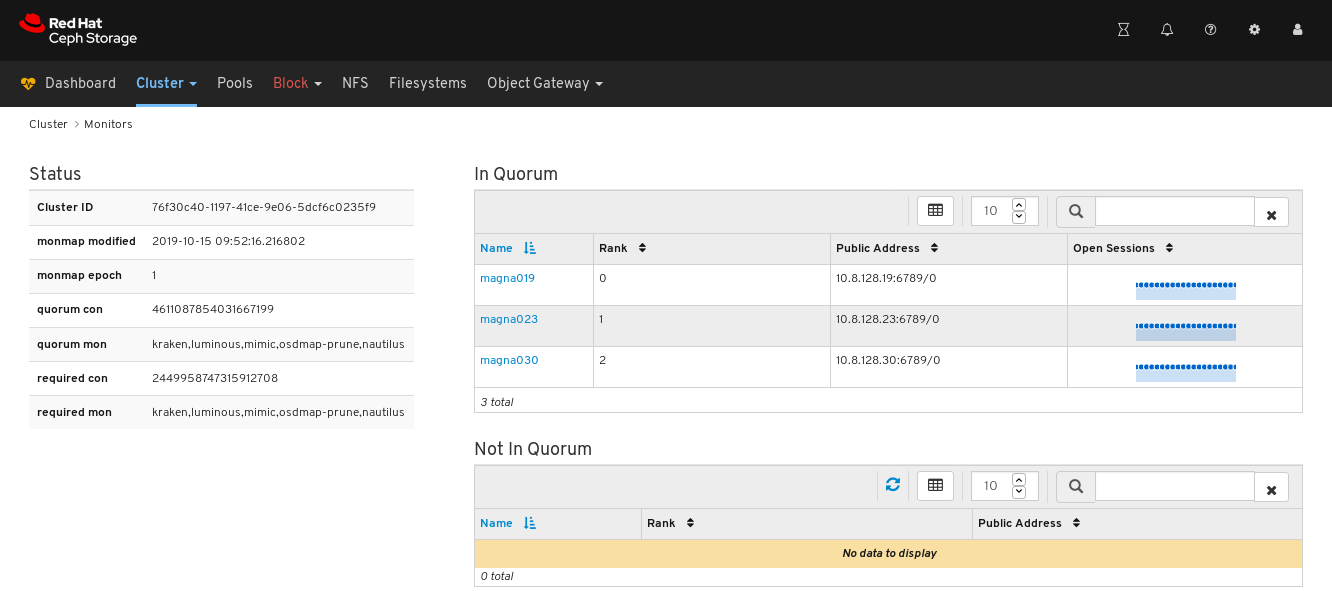

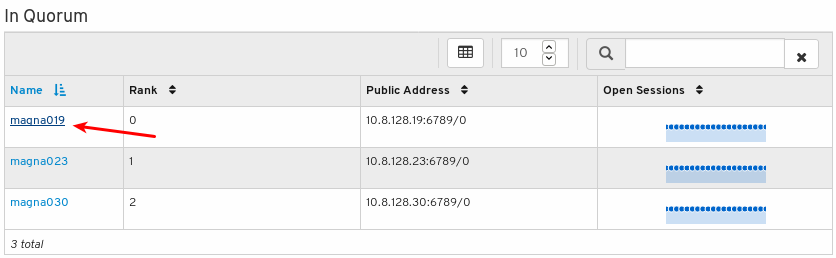

Monitors overview 页面显示有关总体监控状态的信息,以及 Quorum 和 Not in quorum Monitor 节点中的表:

要查看开会话的数量,将光标悬停在蓝色圆点上:

要查看任何监控器的性能计数器,请点击其主机名:

查看性能计数器:

6.2. 监控主机

Red Hat Ceph Storage 仪表板允许您查看有关主机的各种详细信息。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

流程

- 登录到仪表板。

- 在导航栏中,单击 Cluster,然后单击 Hosts。

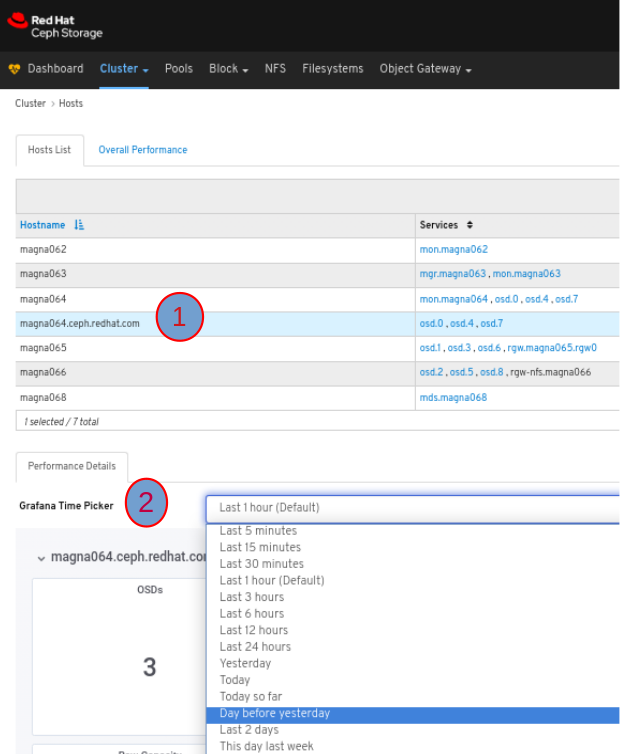

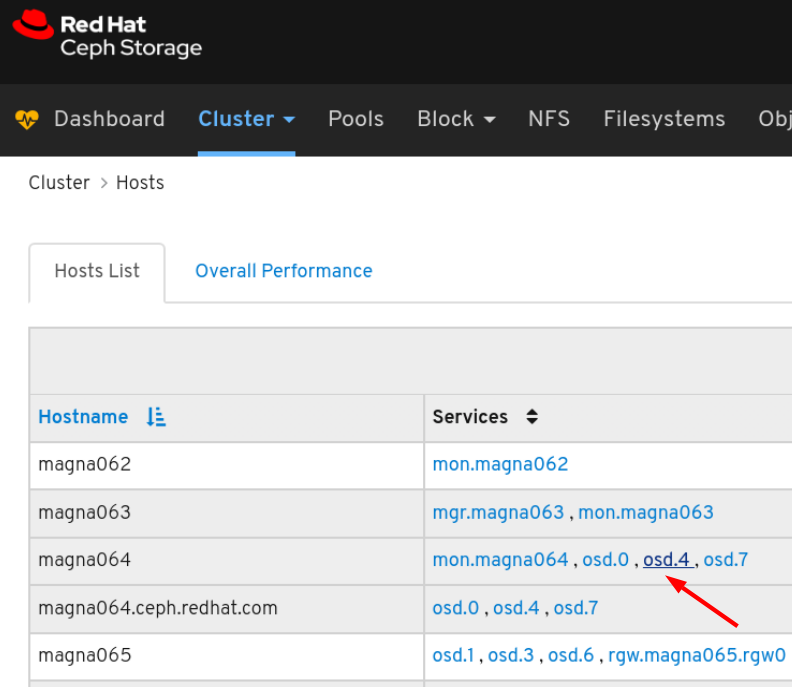

要查看主机列表,请点击 Hosts List 选项卡:

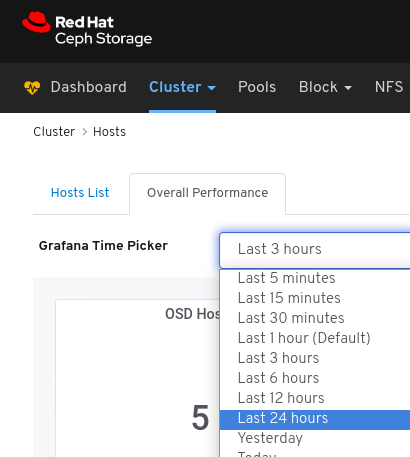

要查看主机的 Performance Details,在 Host 选项卡中点其行,然后从 Grafana Time Picker 下拉菜单中选择时间范围:

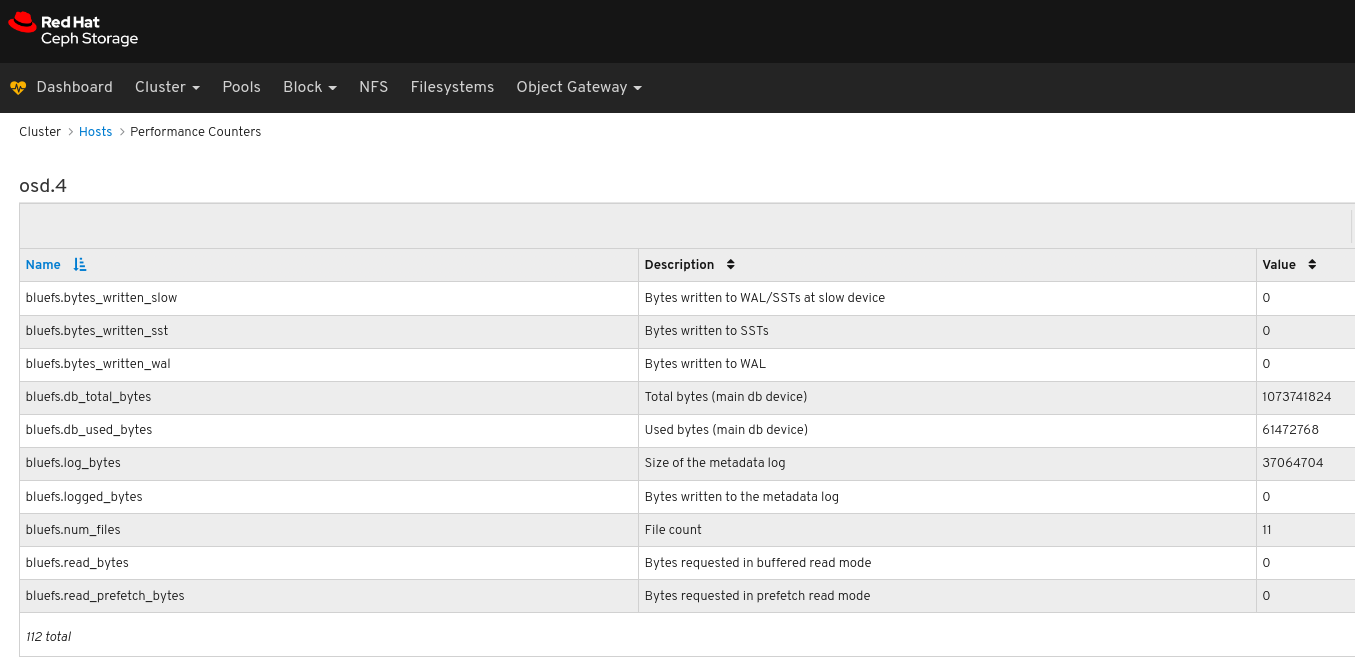

要查看主机上特定服务的性能计数器,请点击该服务:

查看性能计数器:

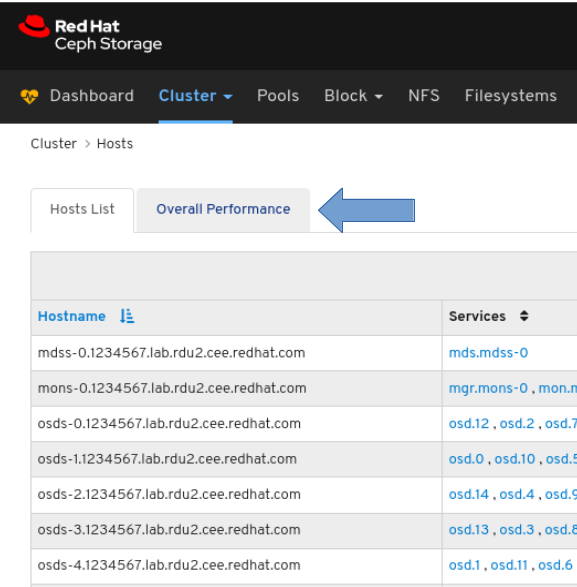

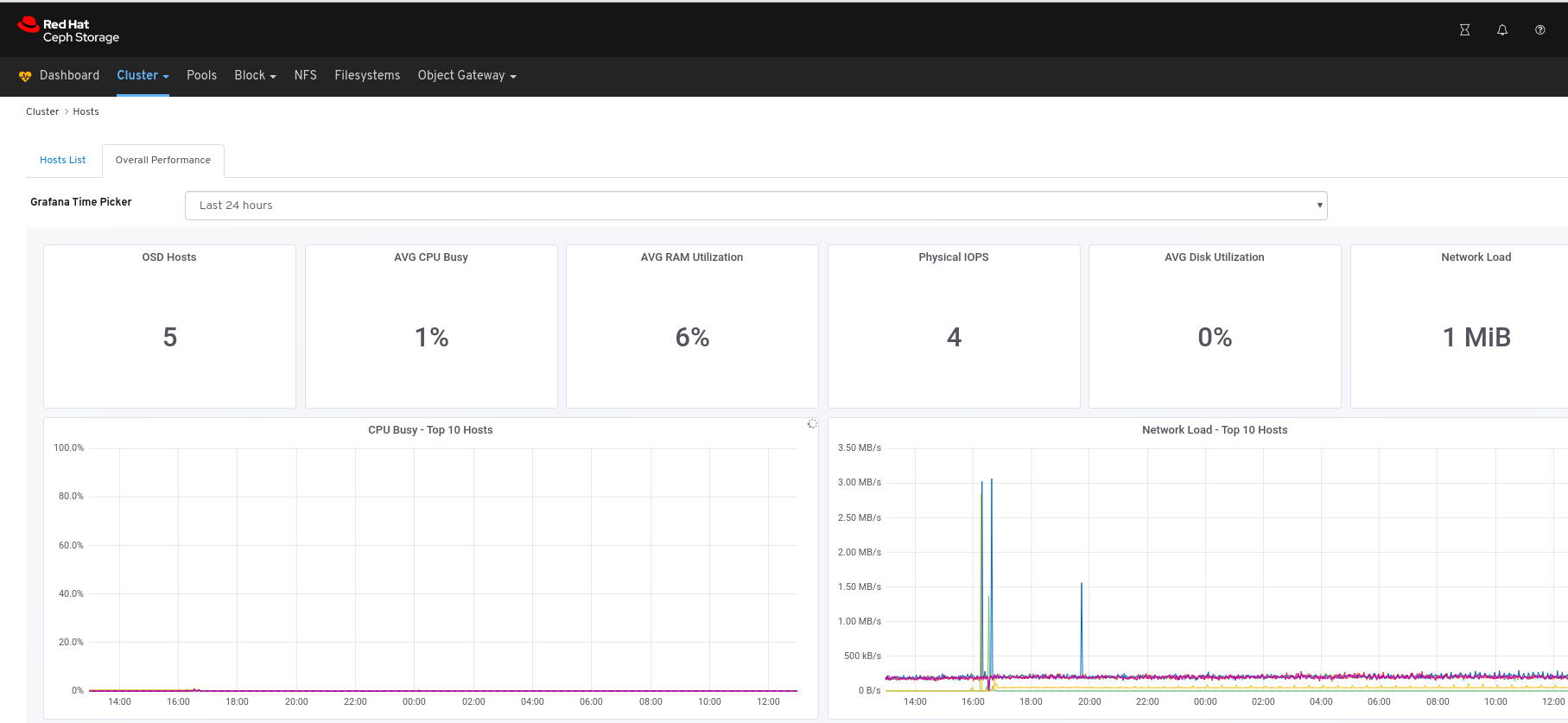

查看所有主机的性能数据:

点击页面左上角的 Overall Performance 选项卡:

从 Grafana Time Picker 下拉菜单中选择时间范围:

查看 Overall Performance 页面:

其它资源

- 如需了解更多详细信息,请参阅 Red Hat Ceph Storage Administration Guide 中的性能计数器。 https://access.redhat.com/documentation/en-us/red_hat_ceph_storage/4/html-single/administration_guide/#performance_counters

6.3. 监控 OSD

Red Hat Ceph Storage Dashboard 允许您查看有关 OSD 的各种详细信息。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

流程

- 登录到仪表板。

- 在导航栏上,单击 Cluster,然后单击 OSD。

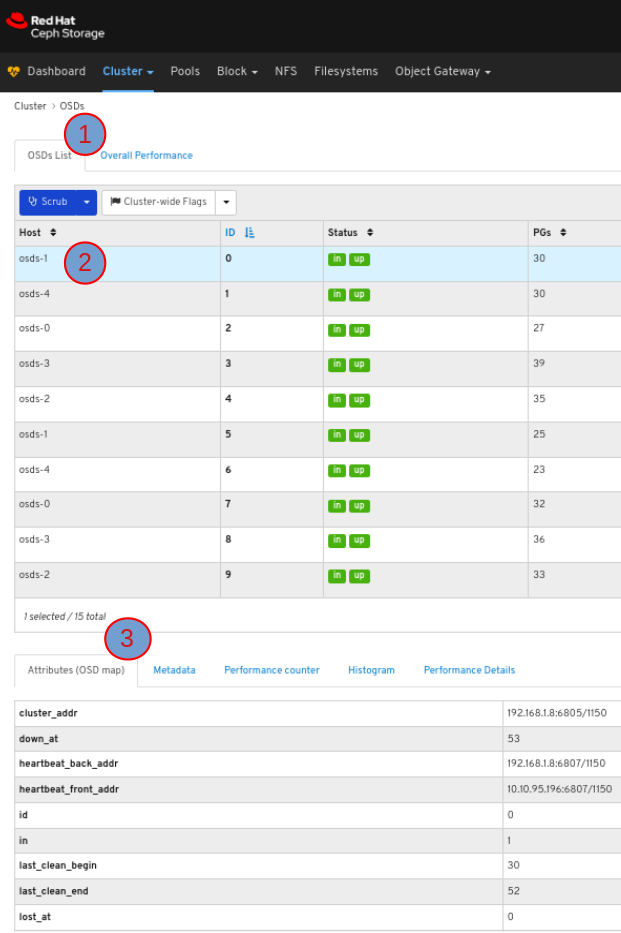

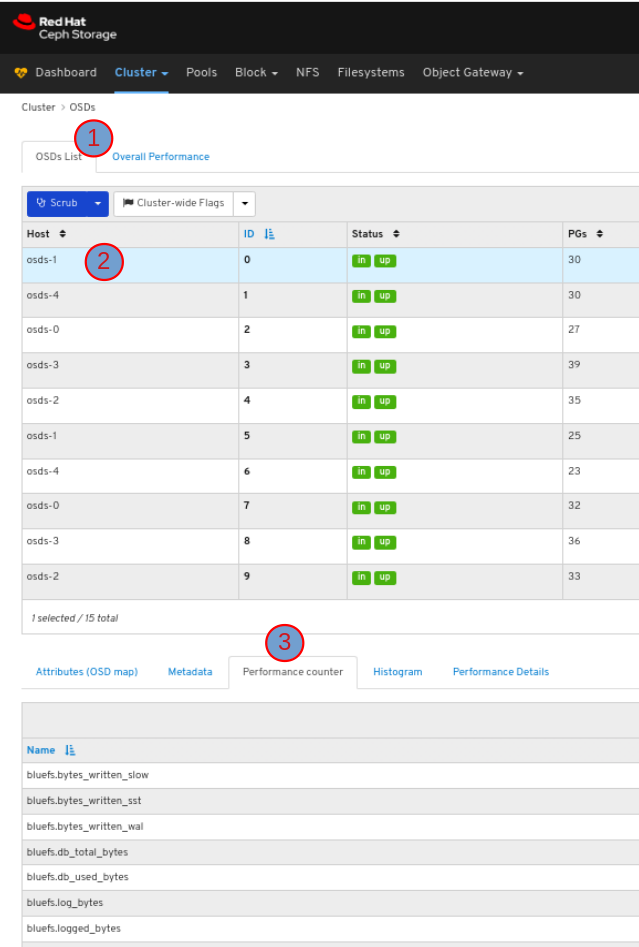

要查看 OSD 列表,请单击 OSD List 选项卡:

要查看 OSD 的属性,在 OSDS List 选项卡上点击其行:

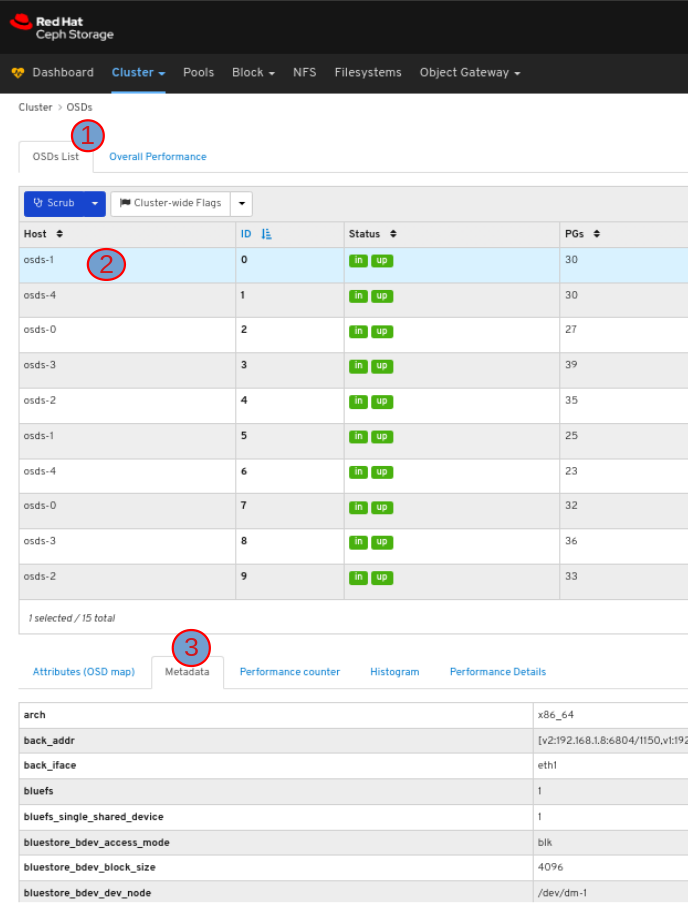

要查看 OSD 的元数据,在 OSD 选项卡中点击其行,再单击 Metadata 选项卡:

要查看 OSD 的性能计数器,请在 OSD 选项卡中单击其行,再单击 Performance counter 选项卡:

要查看 OSD 的直方图,在 OSD 选项卡中单击其行,再单击 Histogram 选项卡:

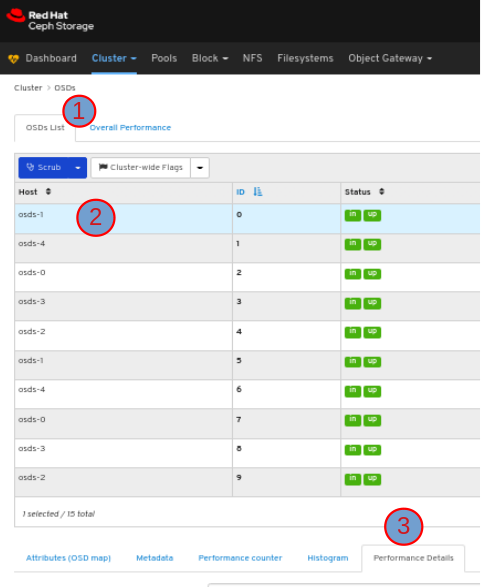

查看 OSD 的性能详情:

在 OSD 选项卡中,点其行,单击 Performance Details 选项卡:

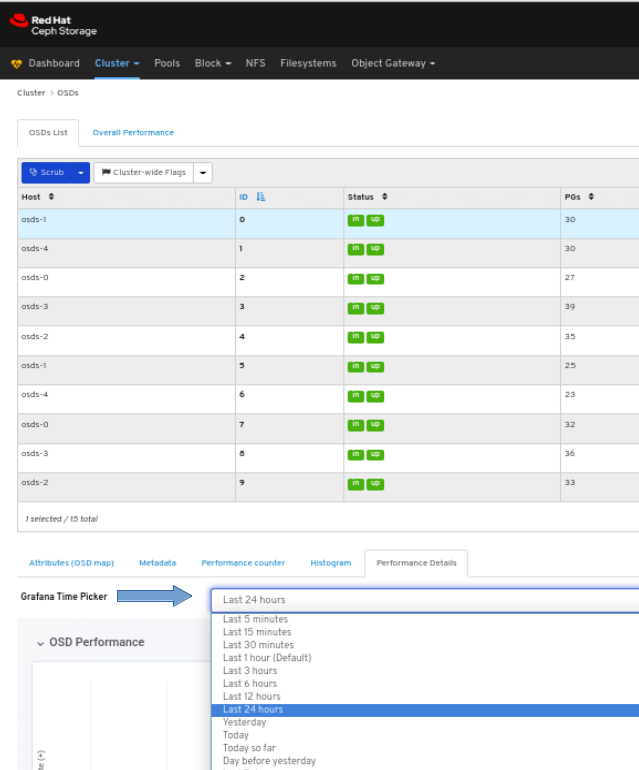

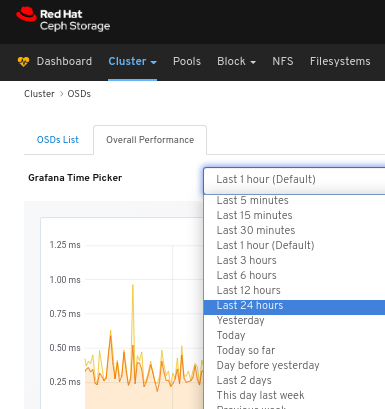

从 Grafana Time Picker 下拉菜单中选择时间范围:

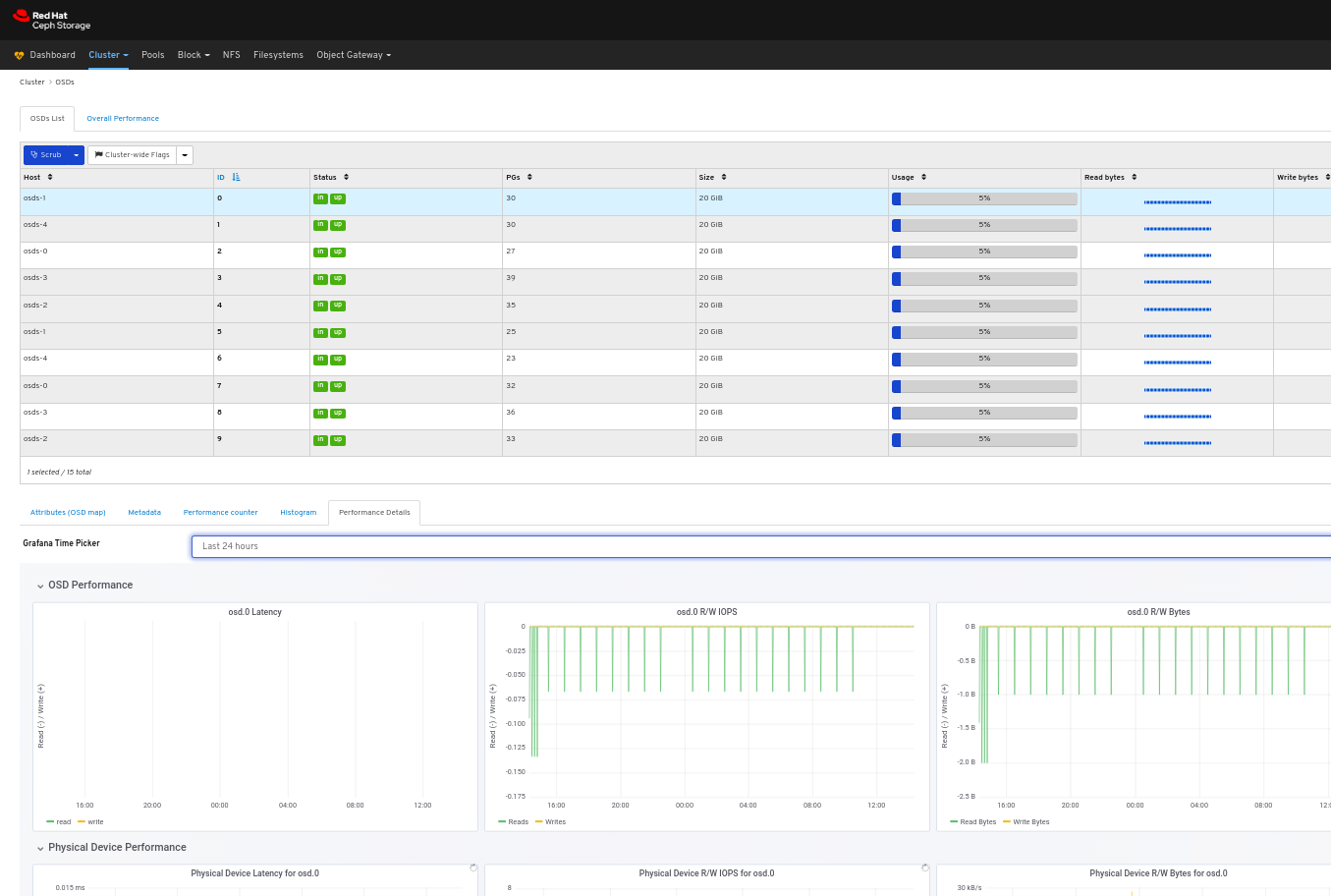

查看 OSD 的性能详情:

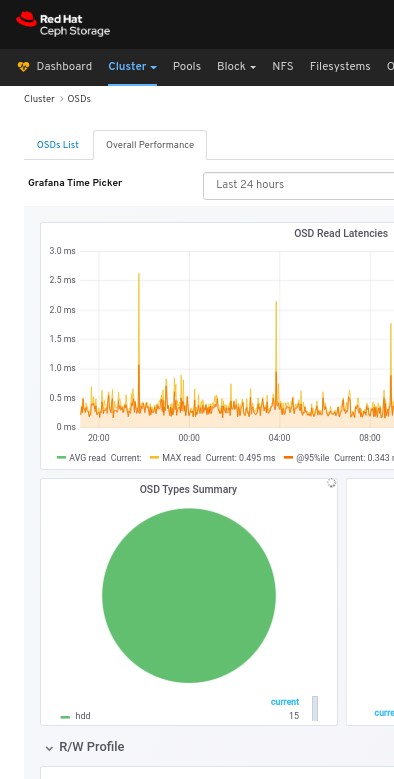

查看所有 OSD 的整体性能:

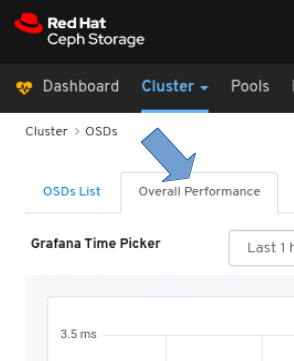

点击页面左上角的 Overall Performance 选项卡 :

从 Grafana Time Picker 下拉菜单中选择时间范围:

查看 Overall Performance 页面:

其它资源

- 如需了解更多详细信息,请参阅 Red Hat Ceph Storage Administration Guide 中的性能计数器。 https://access.redhat.com/documentation/en-us/red_hat_ceph_storage/4/html-single/administration_guide/#performance_counters

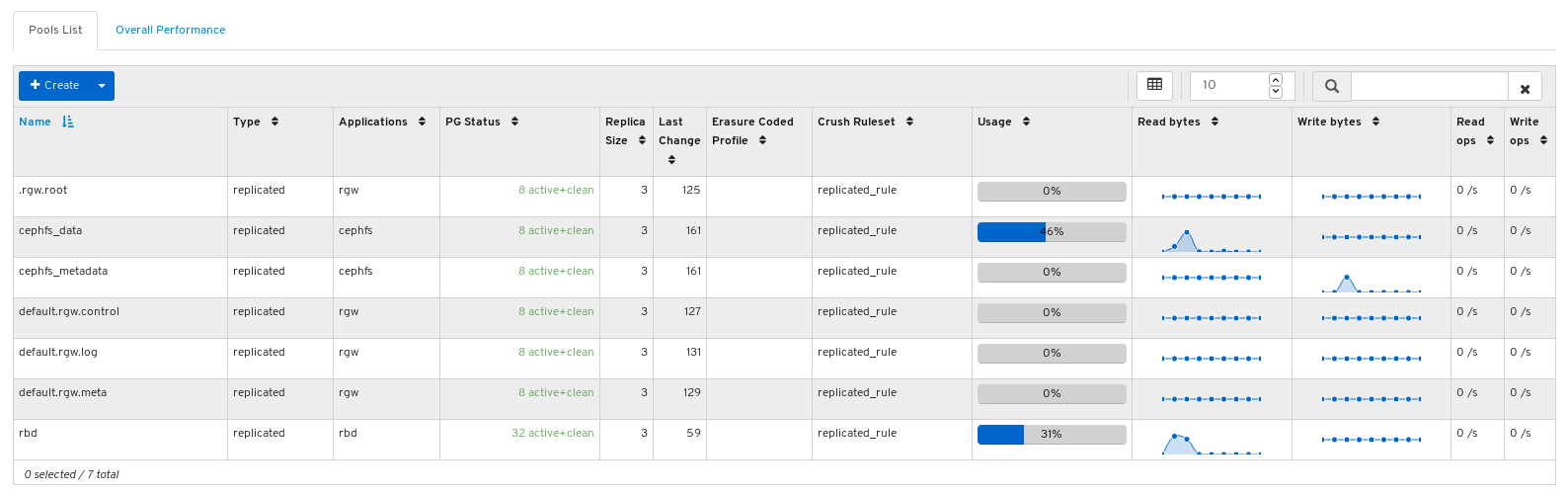

6.4. 监控池

Red Hat Ceph Storage Dashboard 可以查看集群中池的各种详细信息。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

流程

- 登录到仪表板。

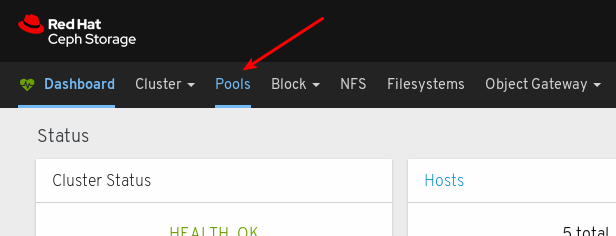

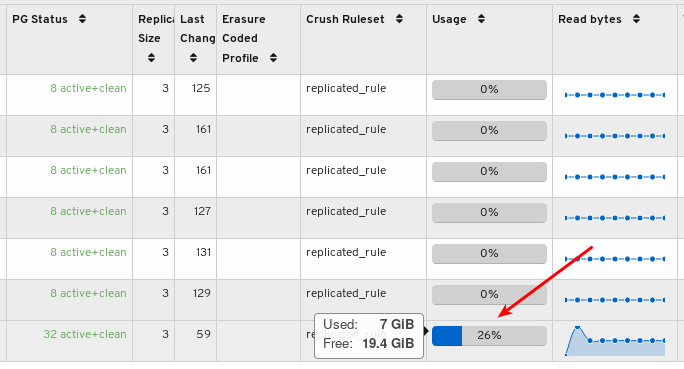

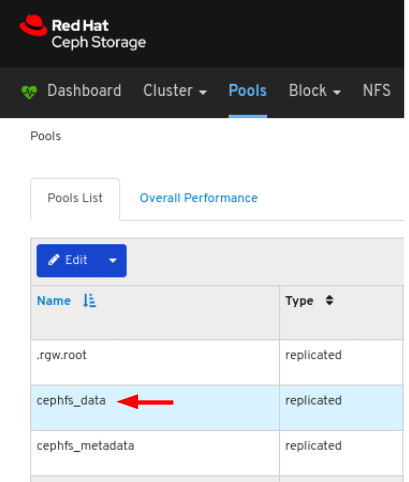

在导航栏中点 Pools :

查看池列表:

将鼠标悬停在使用栏图来查看实际已用空间和可用空间:

要查看有关池的更多信息,请点击其行来选择它:

查看池的详细信息。要查看池的性能详情和配置数据,请单击关联的选项卡。

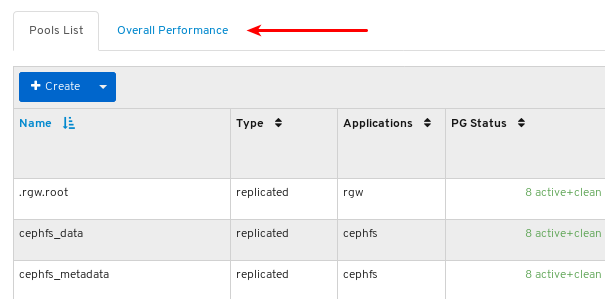

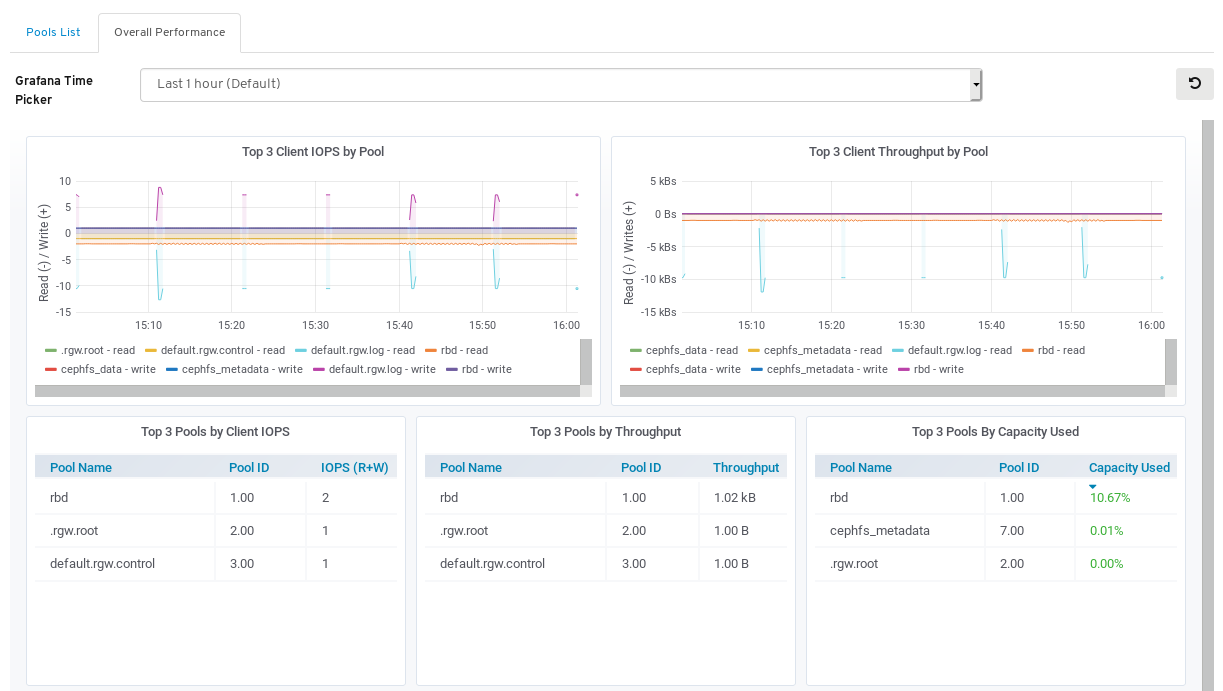

要查看所有池的性能数据,请点击页面左上角的 Overall Performance 选项卡:

查看 Overall Performance 页面:

6.5. 监控 Ceph 文件系统

作为存储管理员,您可以使用 Red Hat Ceph Storage 控制面板监控 Ceph 文件系统(CephFS)和相关组件。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板

- 已安装 Ceph 文件系统。

流程

- 登录控制面板。

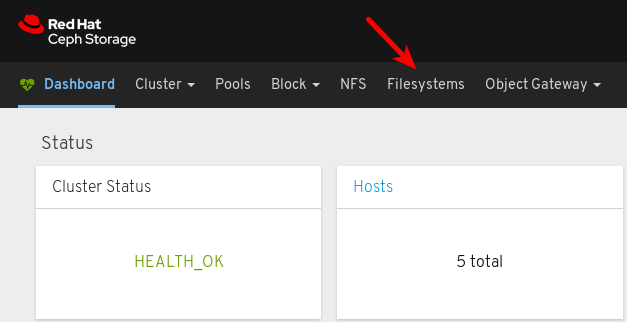

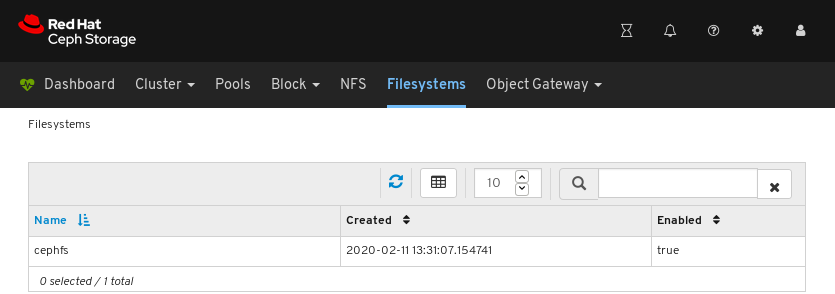

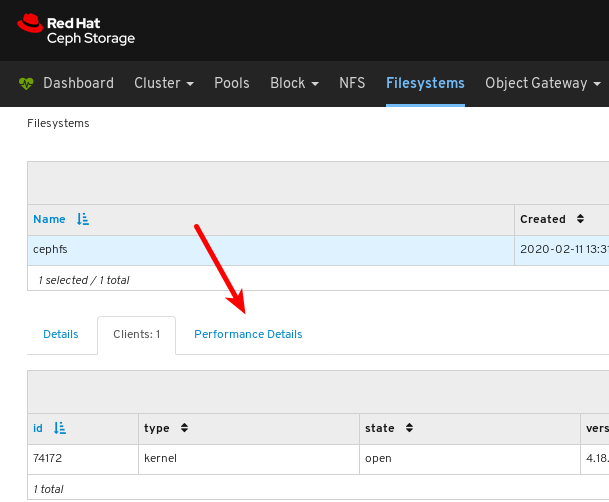

在导航栏中点 Filesystems。

在以下示例中,您可以看到 cephfs 文件系统。

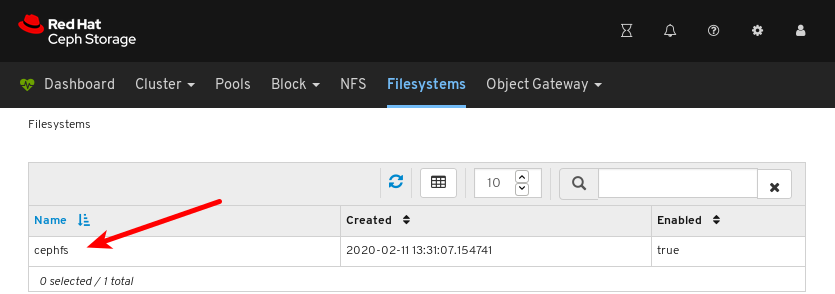

要查看文件系统的详细信息,请单击 cephfs 所在的行。

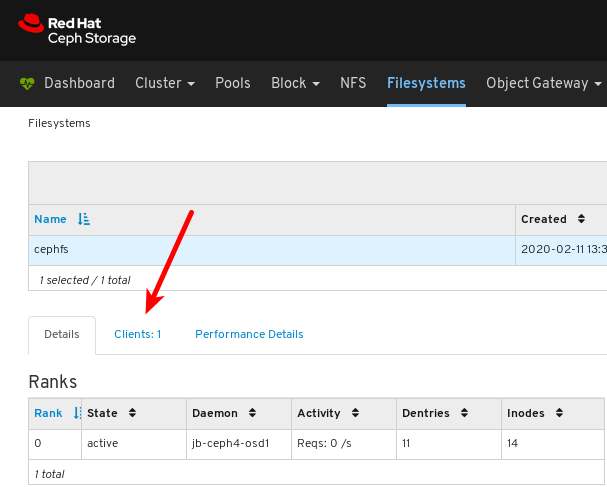

在详细信息 选项卡中,您可以在 2 中看到元数据服务器及其排名以及任意待机后台程序(位于 1、池及其用法)以及 3 的性能计数器。

要查看已挂载文件系统的客户端列表,请点击 Clients 选项卡。

在以下示例中,您可以看到

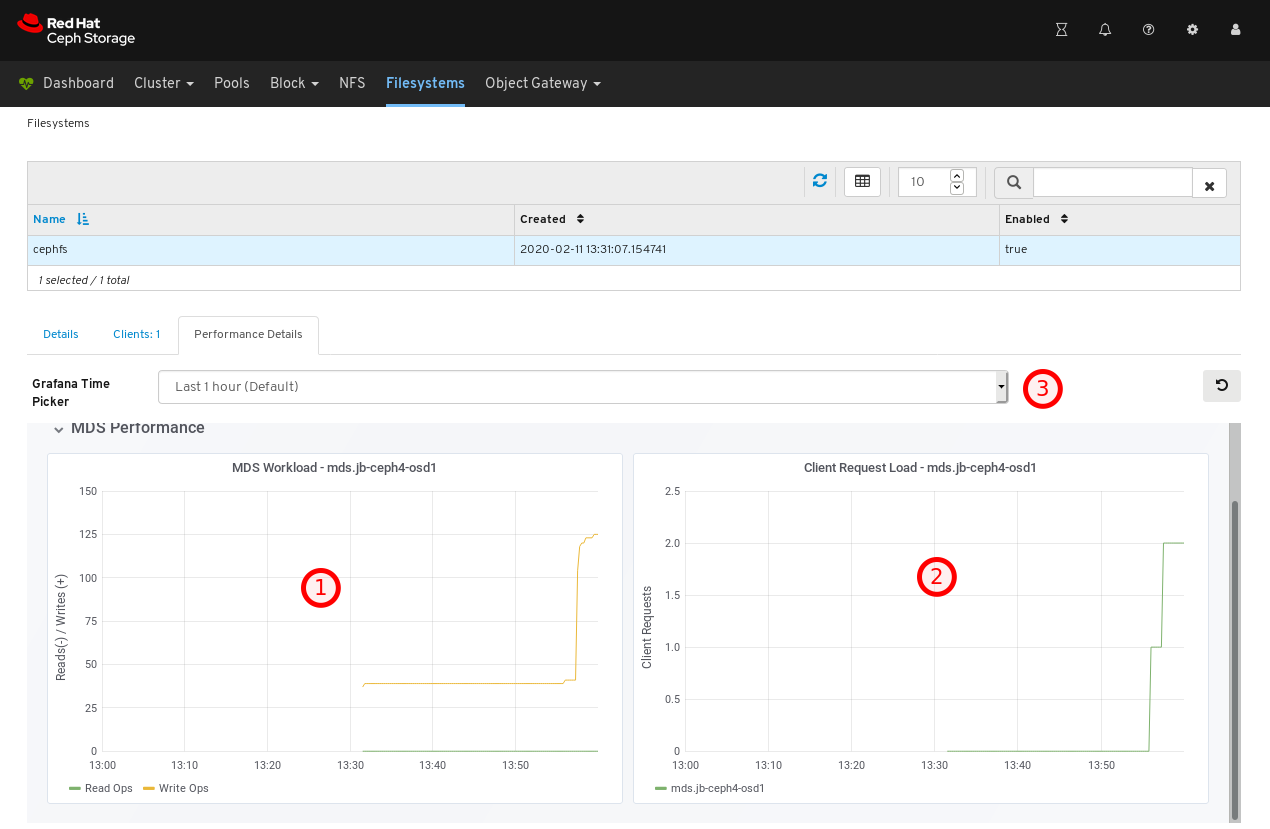

jb-ceph4-client主机已打开 cephfs 文件系统。要查看文件系统的性能,请点击 Performance Details 选项卡。

在以下示例中,您可以在 1、客户端请求 2 查看读取和写入操作,并且您可以在 3 处更改时间范围。

6.6. 监控镜像的整体性能

Red Hat Ceph Storage Dashboard 允许您监控块中镜像的整体性能。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建 RADOS 块设备(RBD)池。

- 已创建镜像。

为池启用 Manager 模块 Prometheus exporter。

图 6.1. 示例

流程

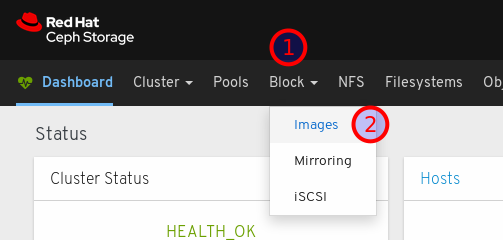

- 登录到仪表板。

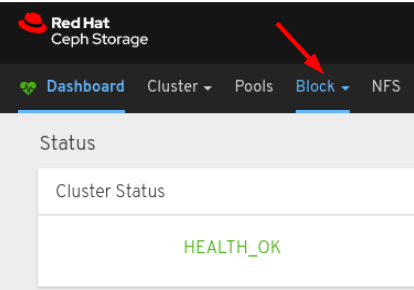

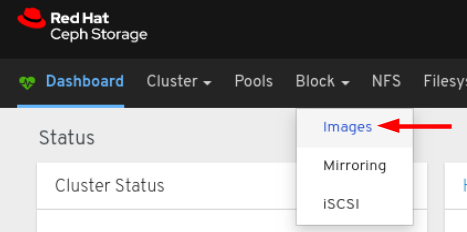

在导航栏中,点 Block :

从下拉菜单中选择 Images :

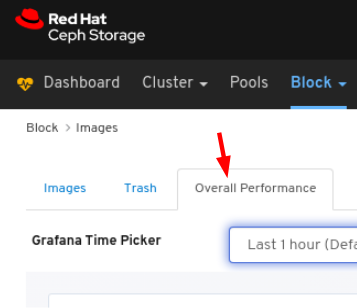

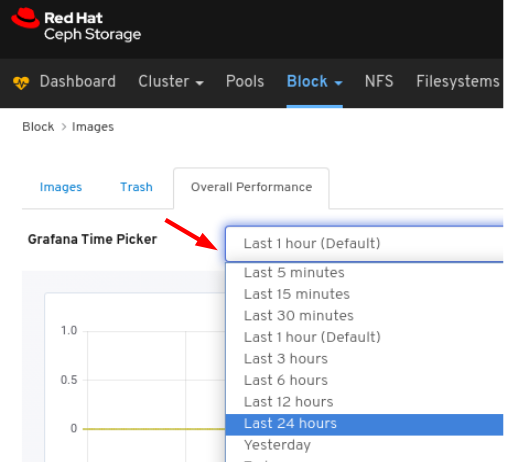

选择 Overall Performance 选项卡:

从 Grafana Time Picker 下拉菜单中选择时间范围:

查看 Overall Performance 页面:

第 7 章 管理集群

7.1. 管理集群

仪表板的管理功能允许您查看和修改配置设置,并管理集群资源。

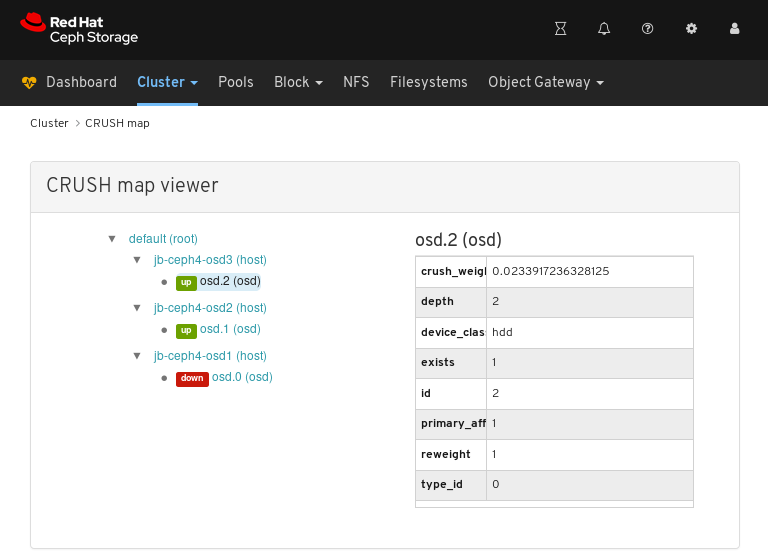

7.2. 查看 CRUSH map

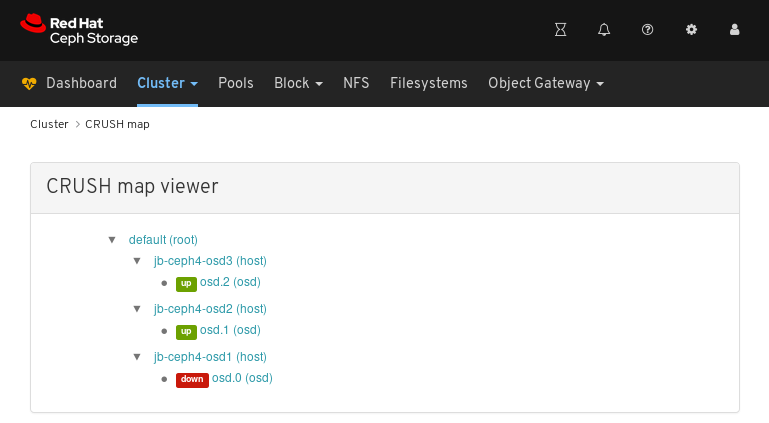

CRUSH map 包含 OSD 和相关信息的列表。CRUSH map 和 CRUSH 算法一起确定数据的保存方式和位置。Red Hat Ceph Storage 仪表板允许您查看 CRUSH map 的不同方面,包括 OSD 主机、OSD 守护进程、ID 号、设备类等。

CRUSH map 允许您确定特定 OSD ID 正在运行的节点。如果 OSD 存在问题,这很有用。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

流程

- 登录到仪表板。

- 在导航栏中,单击 Cluster。

单击 CRUSH map。

在上例中,您可以看到在三个节点上运行的默认 CRUSH map、三个节点和 OSD。

单击 CRUSH map 名称、节点或 OSD,以查看各个对象的详细信息。

在上例中,您可以看到与

jb-rhel-osd3节点上运行的 OSD 相关的变量的值。特别是,id是2。

其它资源

- 有关 CRUSH map 的更多信息,请参阅 存储策略指南中的 CRUSH 管理。

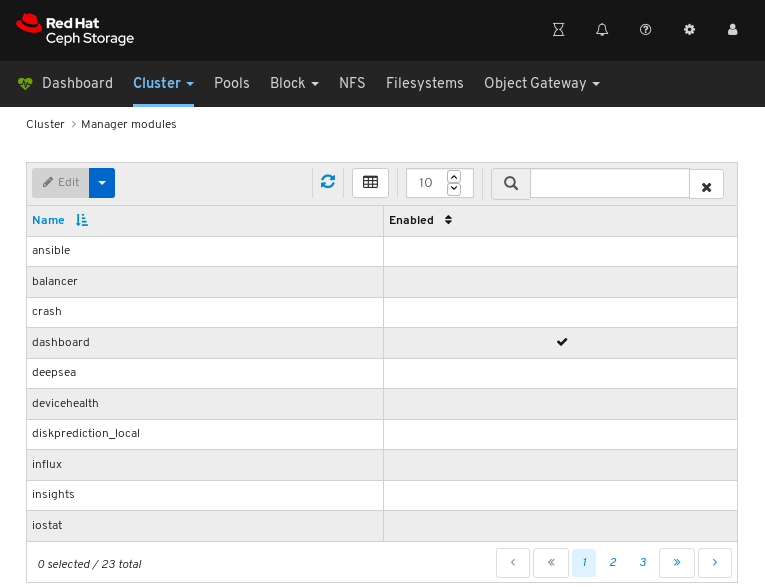

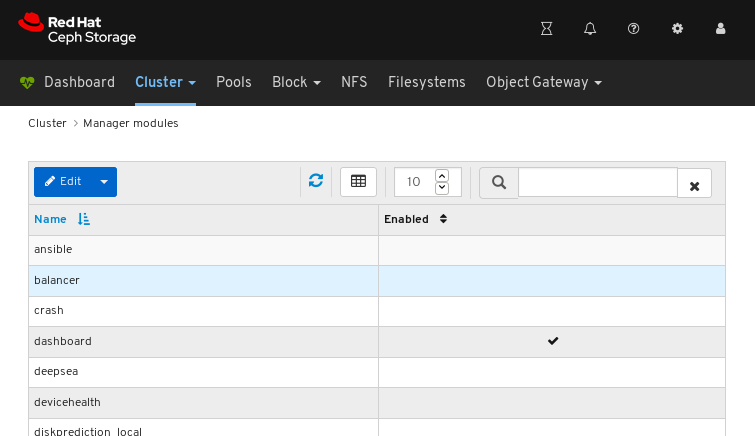

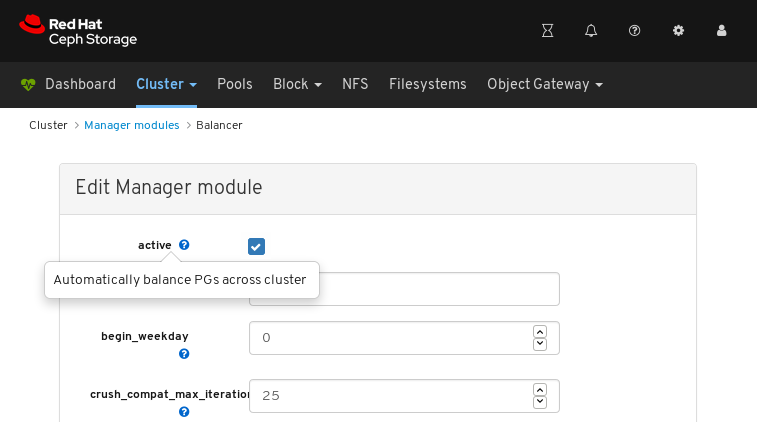

7.3. 配置管理器模块

Red Hat Ceph Storage 仪表板允许您查看并配置管理器模块参数。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

流程

- 登录到仪表板。

- 在导航栏中,单击 Cluster。

点 Manager 模块 :

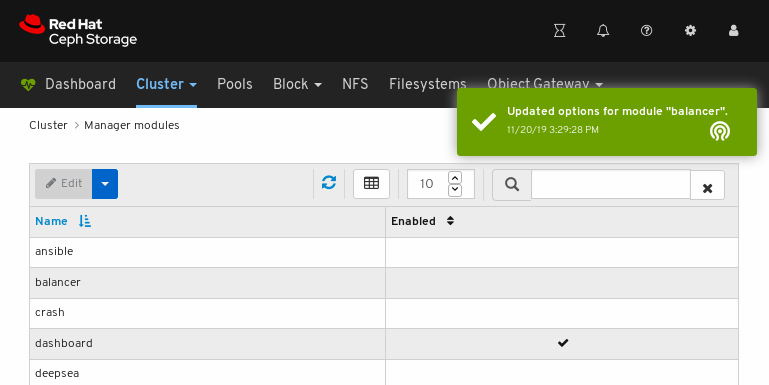

以上屏幕截图显示了管理器模块的三个页面中的第一个。

点击您要配置的模块的行:

并非所有模块都具有可配置参数。如果模块不可配置,则 Edit 按钮会被禁用。

在页面左上角,单击 Edit 按钮,以使用可配置参数加载页面。

以上屏幕截图显示了您可以更改 balancer 模块的参数。要显示参数描述,请单击问号按钮。

要更改参数,修改参数的状态并点击页面底部的 更新 按钮:

确认更改的通知会出现在页面的右上角:

其它资源

- 请参阅 Red Hat Ceph Storage Operations 指南中的使用 CephManager balancer 模块 。

7.4. 过滤日志

Red Hat Ceph Storage Dashboard 允许您根据以下标准查看和过滤日志。该条件包括 优先级、关键字、日期和时间 范围。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 安装了 Dashboard。

- 由于 monitor 上次启动,因此日志条目已经生成。

控制面板日志记录功能仅显示三十最新高级别事件。事件由 monitor 存储在内存中。在重新启动 monitor 后,条目会消失。如果您需要查看详细或旧的日志,请参阅基于文件的日志。有关 基于文件的日志的更多信息,请参阅下面的额外资源。

流程

- 登录到仪表板。

-

点导航栏中的

Cluster下拉菜单。 -

在下拉菜单中选择

Logs。 查看最后 thirty unfiltered 日志条目。

要根据优先级过滤,请点击

Priority下拉菜单并选择Info、警告或错误。以下示例仅显示优先级为Error的日志条目。要按关键字过滤,请在

关键字表单中输入文本。下例中仅显示包含文本osd.2的日志条目。要根据日期进行过滤,请点击

Date表单,并使用 date picker 从菜单中选择日期,或者以 YYYY-MM-DD 的形式输入日期。以下示例仅显示2019-10-15日期的日志条目。要按时间过滤,请使用 HH:MM - HH:MM 格式在

时间范围字段中输入范围。小时需要是数字0到23。以下示例仅显示从12:14到12:23的日志条目。要组合过滤器,请设置两个或更多过滤器。以下示例仅显示优先级为

Warning和osd关键字的条目。

其它资源

- 如需更多信息,请参阅故障排除指南中的 配置日志记录 章节。

- 如需更多信息,请参阅故障排除指南中的 了解 Ceph 日志 部分。

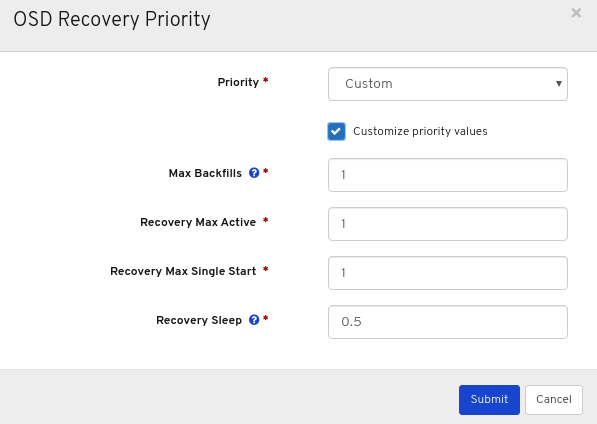

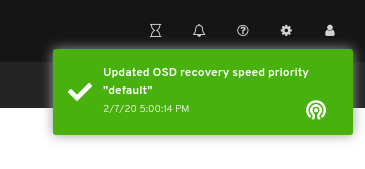

7.5. 配置 OSD 恢复设置

作为存储管理员,您可以更改 OSD 恢复优先级,并自定义集群恢复方式。这可让您影响集群的重建性能或恢复速度。

先决条件

- 红帽 Ceph 存储集群.

- 已安装控制面板。

流程

- 登录控制面板。

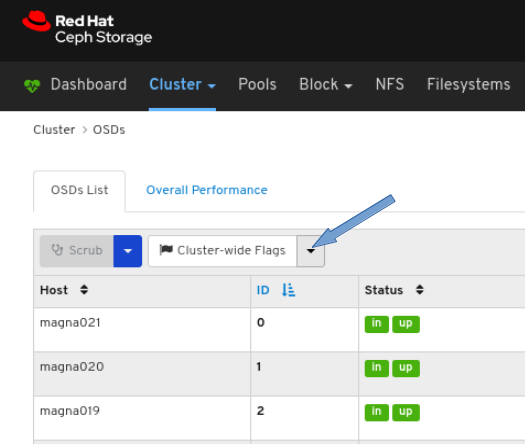

- 点导航栏中的 Cluster 下拉菜单。

- 从下拉菜单中选择 OSD。

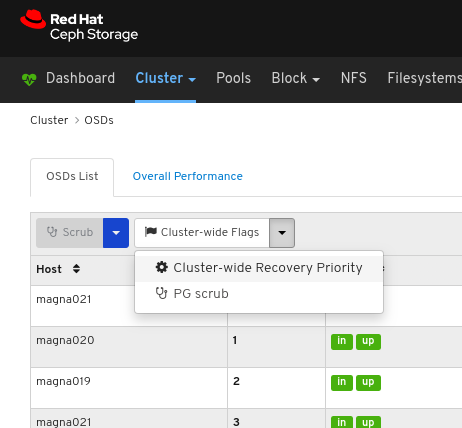

点 Cluster-Wide Flags 下拉菜单。

在下拉菜单中选择 Cluster-wide Recovery Priority。

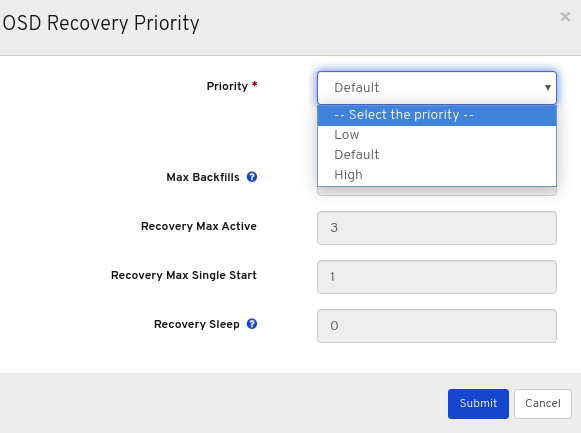

可选:在下拉菜单中选择 优先级,然后单击" 提交 "按钮。

注意有三个预定义的选项: Low、Default、High

可选:点击 Customize priority values,进行所需的更改,然后单击 Submit 按钮。

弹出表示已成功更新页面右上角的通知。

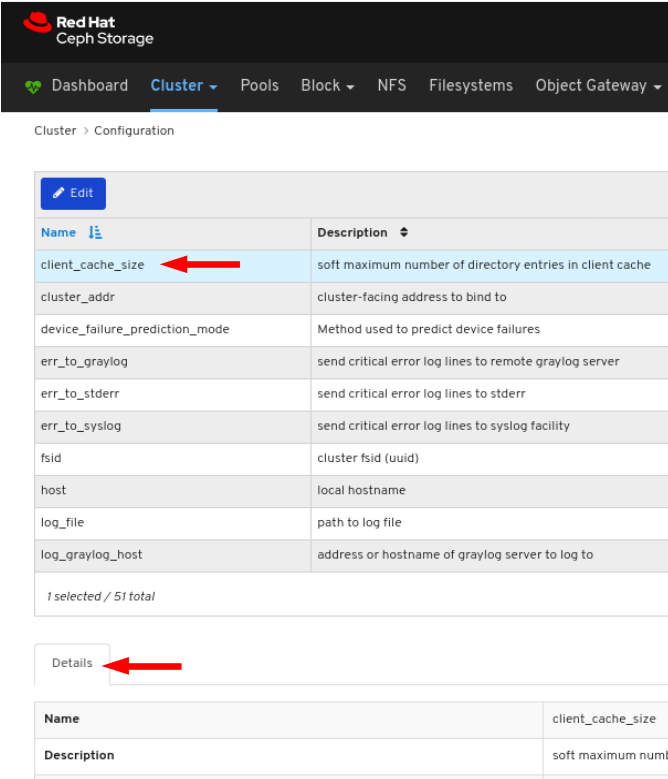

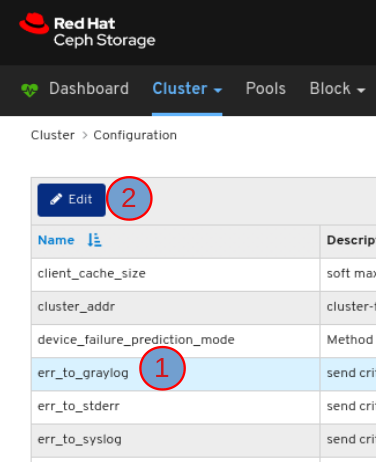

7.6. 查看和监控配置

Red Hat Ceph Storage 控制面板可以查看 Ceph 集群的所有配置选项列表。您还可以在控制面板中编辑配置。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

流程

- 登录到仪表板。

- 在导航栏中,单击 Cluster,然后单击 Configuration。

要查看配置详情,请点击其行:

您可以使用 Search 框搜索配置:

您可以使用 Level、Service 或 Source 下拉菜单中选择配置:

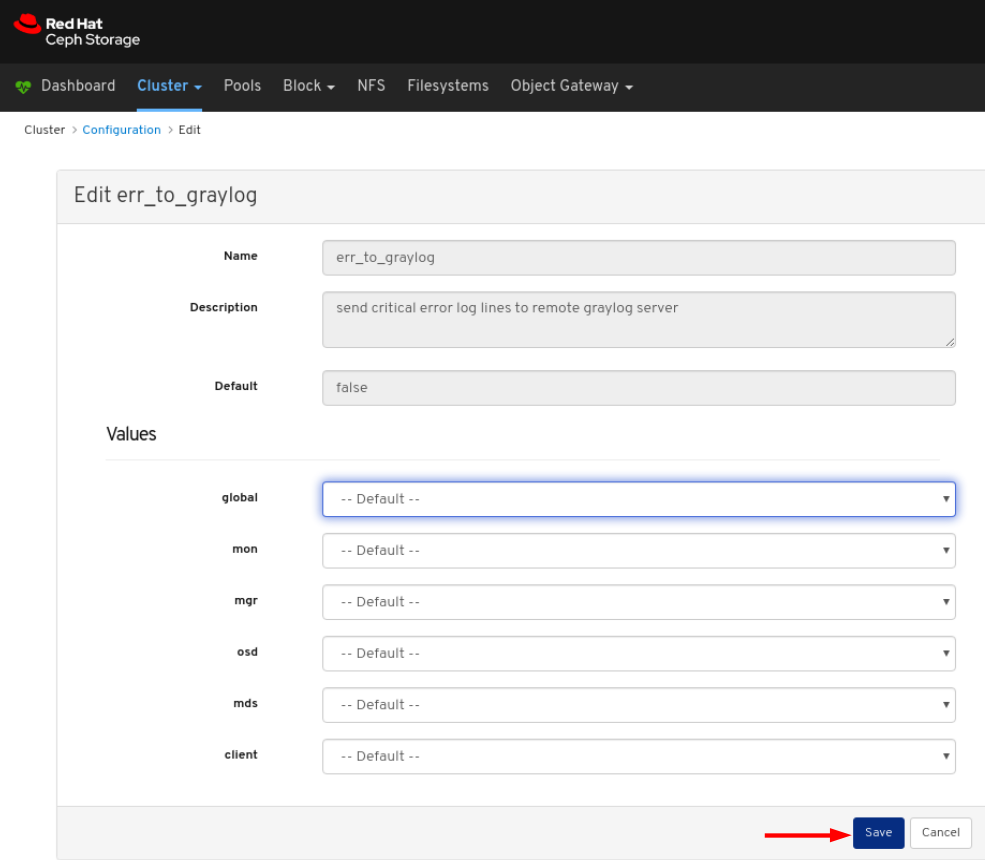

要编辑配置,点其行并点 Edit 按钮:

在对话窗口中,编辑所需参数并点 Save 按钮:

确认更改的通知会出现在页面右上角。

其它资源

- 如需了解更多详细信息,请参阅 Red Hat Ceph Storage Configuration Guide 中的 Ceph 网络配置章节。 https://access.redhat.com/documentation/en-us/red_hat_ceph_storage/4/html-single/configuration_guide/#ceph-network-configuration

7.7. 管理 Prometheus 环境

要使用 Prometheus 监控 Ceph 存储集群,您可以配置和启用 Prometheus 导出器,以便可以收集与 Ceph 存储集群相关的元数据信息。

先决条件

- 正在运行的 Red Hat Ceph Storage 3.1 或更高版本的集群。

- 安装红帽 Ceph 存储仪表板.

- Red Hat Ceph Storage 仪表板节点的 root 级别访问。

流程

打开并编辑

/etc/prometheus/prometheus.yml文件。在

global部分下,将scrape_interval和evaluation_interval选项设置为 15 秒。示例

global: scrape_interval: 15s evaluation_interval: 15s

global: scrape_interval: 15s evaluation_interval: 15sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

scrape_configs部分下,添加honor_labels: true选项,并为每个ceph-mgr节点编辑目标和实例选项。示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意使用

honor_labels选项可让 Ceph 输出与 Ceph 存储集群中任何节点相关的正确标记数据。这样,Ceph 可以在不覆盖 Prometheus 的情况下导出正确的实例标签。要添加新节点,只需以以下格式添加

目标和实例选项:示例

- targets: [ 'new-node.example.com:9100' ] labels: instance: "new-node"- targets: [ 'new-node.example.com:9100' ] labels: instance: "new-node"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意instance标签必须与 Ceph 的 OSD 元数据实例字段中显示的内容匹配,这是节点的短主机名。这有助于将 Ceph 统计数据与节点的统计相关联。

将 Ceph 目标添加到

/etc/prometheus/ceph_targets.yml文件,格式为:示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 启用 Prometheus 模块:

ceph mgr module enable prometheus

[root@mon ~]# ceph mgr module enable prometheusCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8. 恢复 grafana-server 和 Prometheus

grafana-server 包括 Grafana UI、Prometheus、容器和 Red Hat Ceph Storage 配置。当 grafana-server 崩溃或有故障时,您可以通过备份文件并使用备份的文件恢复它。对于 Prometheus,您可以进行外部备份,然后恢复数据。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 对 Grafana 节点进行根级访问。

流程

恢复 Grafana 数据库:

在 grafana-server 节点上,停止 Grafana 服务:

示例

systemctl stop grafana-server.service systemctl status grafana-server.service

[root@node04 ~]# systemctl stop grafana-server.service [root@node04 ~]# systemctl status grafana-server.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 恢复 Grafana 数据库:

示例

cp /var/lib/grafana/grafana.db /var/lib/grafana/grafana_backup.db

[root@node04 ~]# cp /var/lib/grafana/grafana.db /var/lib/grafana/grafana_backup.dbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在 grafana-server 节点上,重启 Grafana 服务:

示例

systemctl restart grafana-server.service

[root@node04 ~]# systemctl restart grafana-server.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

恢复 grafana-server:

在 grafana-server 节点上,如果 Grafana 服务处于运行状态,停止该服务:

示例

systemctl stop grafana-server.service systemctl status grafana-server.service

[root@node04 ~]# systemctl stop grafana-server.service [root@node04 ~]# systemctl status grafana-server.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将支持的

grafana.db文件移动到/var/lib/grafana/目录中:示例

mv /var/lib/grafana/grafana_backup.db /var/lib/grafana/

[root@node04 ~]# mv /var/lib/grafana/grafana_backup.db /var/lib/grafana/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在 grafana-server 节点上,重启 Grafana 服务:

示例

systemctl restart grafana-server.service

[root@node04 ~]# systemctl restart grafana-server.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

对于 Prometheus 警报,您必须提取

prometheus_data_dir目录的外部备份,即 Ceph-Ansible 设置,默认为var/lib/prometheus目录,并使用备份的目录恢复该服务。在 grafana-server 节点上,停止 Prometheus 服务:

示例

systemctl stop prometheus.service systemctl status prometheus.service

[root@node04 ~]# systemctl stop prometheus.service [root@node04 ~]# systemctl status prometheus.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 备份默认 Prometheus 目录:

示例

cp /var/lib/prometheus/ /var/lib/prometheus_backup/

[root@node04 ~]# cp /var/lib/prometheus/ /var/lib/prometheus_backup/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将

prometheus_data_dir目录替换为支持的目录:示例

mv /var/lib/prometheus_backup/ /var/lib/prometheus_data_dir

[root@node04 ~]# mv /var/lib/prometheus_backup/ /var/lib/prometheus_data_dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在 grafana-server 节点上,重启 prometheus 服务:

示例

systemctl restart prometheus.service systemctl status prometheus.service

[root@node04 ~]# systemctl restart prometheus.service [root@node04 ~]# systemctl status prometheus.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意如果您更改了

group_vars/all.yml文件中的 Prometheus 参数,则必须重新运行 playbook。

可选:如果更改没有反映在 Red Hat Ceph Storage 仪表板中,则必须禁用并启用仪表板:

示例

ceph mgr module disable dashboard ceph mgr module enable dashboard

[root@node04 ~]# ceph mgr module disable dashboard [root@node04 ~]# ceph mgr module enable dashboardCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.9. 查看和管理警报

作为存储管理员,您可以在 Red Hat Ceph Storage 仪表板中查看警报的详细信息,并为它们创建静默。这包括以下预定义警报:

- OSD 故障

- Ceph Health 错误

- Ceph Health Warning

- 集群容量低

- 磁盘 Near Full

- MON Down

- 网络错误

- OSD 主机丢失检查

- OSD 主机故障

- 带有高 PG 数的 OSD

- PG(s)Stuck

- 池容量低

- OSD 响应缓慢

7.9.1. 查看警报

触发警报后,您可以在 Red Hat Ceph Storage 控制面板查看它。您还可以启用仪表板来发送电子邮件到警报。

Red Hat Ceph Storage 4 集群中不支持简单邮件传输协议(SMTP)和 SSL。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 触发警报。

流程

- 登录到仪表板。

在 仪表板上自定义警报 模块,以获取存储集群的电子邮件警报:

- 在导航栏中,单击 Cluster。

- 选择 Manager 模块。

- 选择 警报 模块。

- 在 Edit 下拉菜单中,选择 Edit。

在 Edit Manager 模块 中,更新所需的参数并点 Update。

图 7.1. 为警报编辑 Manager 模块

- 在导航栏中,单击 Cluster。

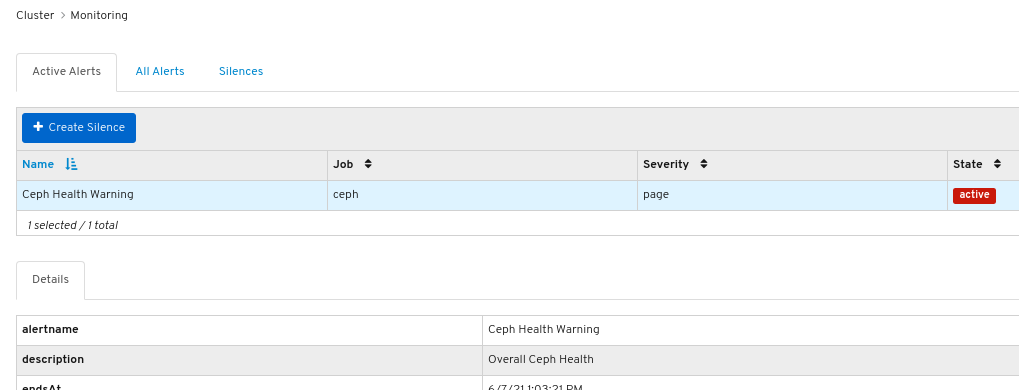

- 从下拉菜单中选择 Monitoring。

要查看警报的详情,请点击它的行:

图 7.2. 警报详情

- 要查看警报的来源,请单击其行,然后单击 Source。

7.9.2. 创建静默

您可以在 Red Hat Ceph Storage 仪表板中针对指定时间为警报创建静默。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 触发警报。

流程

- 登录到仪表板。

- 在导航栏中,单击 Cluster。

- 从下拉菜单中选择 Monitoring。

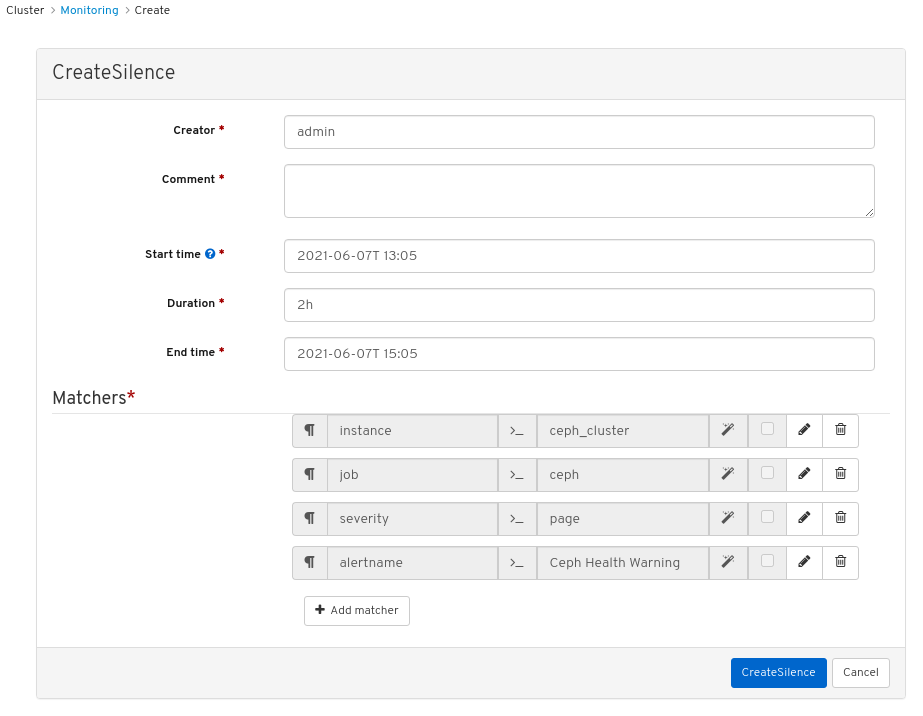

- 单击警报所在的行,然后单击 +Create Silence。

在 CreateSilence 窗口中,添加 Duration 的详细信息并点 Create Silence。

图 7.3. 创建 Silence

- 您会看到一个通知,说明静默已创建成功。

7.9.3. 重新创建静默

您可以从 Red Hat Ceph Storage Dashboard 的过期静默重新创建静默。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 触发警报。

- 为警报创建的静默。

流程

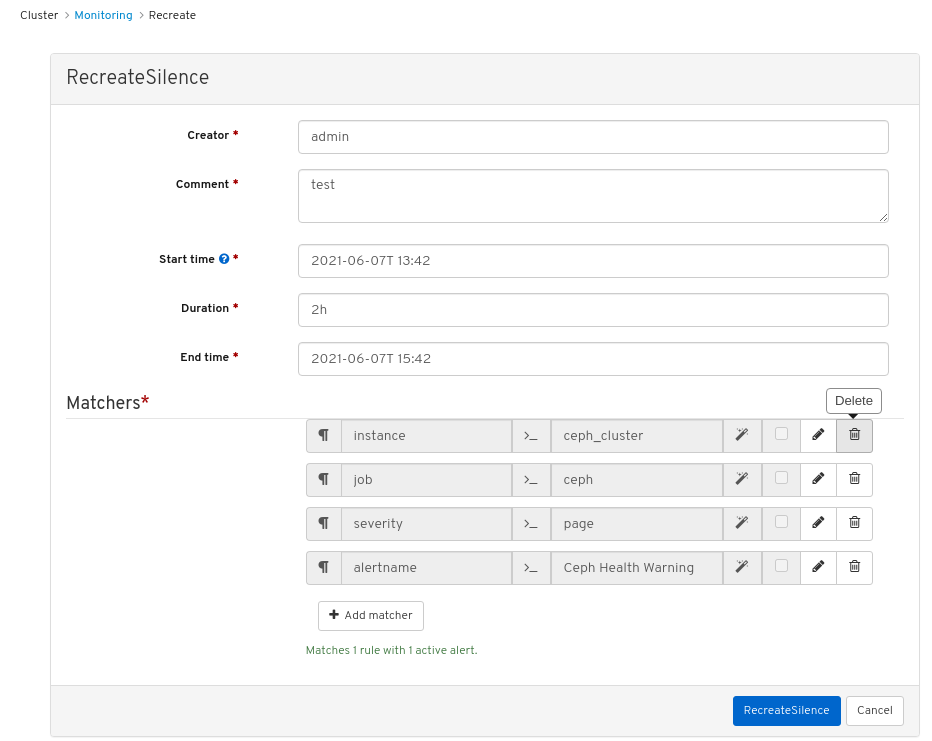

- 登录到仪表板。

- 从下拉菜单中选择 Monitoring。

- 点 Silences 选项卡。

- 点击已过期静默所在的行。

- 点 Recreate 按钮。

在 RecreateSilence 窗口中,添加详情并点击 RecreateSilence。

图 7.4. 重新创建静默

- 您会看到一个通知,说明静默已被成功重新创建。

7.9.4. 编辑静默

您可以编辑活跃的静默,例如在 Red Hat Ceph Storage 仪表板中扩展它处于活跃状态的时间。如果静默已过期,您可以重新创建静默,或为警报创建新静默。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 触发警报。

- 为警报创建的静默。

流程

- 登录到仪表板。

- 在导航栏中,单击 Cluster。

- 从下拉菜单中选择 Monitoring。

- 点 Silences 选项卡。

- 点击静默所在的行。

- 在 Edit 下拉菜单中,选择 Edit。

在 EditSilence 窗口中,更新详情并点击 Edit Silence。

图 7.5. 编辑静默

- 您会看到一个通知,说明静默已被成功更新。

7.9.5. 使静默到期

您可以使静默到期,以便在 Red Hat Ceph Storage 仪表板中不隐藏匹配的警报。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 触发警报。

- 为警报创建的静默。

流程

- 登录到仪表板。

- 在导航栏中,单击 Cluster。

- 从下拉菜单中选择 Monitoring。

- 点 Silences 选项卡。

- 点击静默所在的行。

- 在 Edit 下拉菜单中,选择 Expire。

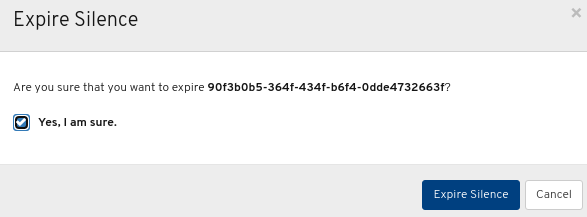

在 Expire Silence 对话框中,选择 Yes, I am sure,然后单击 Expire Silence。

图 7.6. 过期的静默

- 您会看到一个通知,该静默已成功过期。

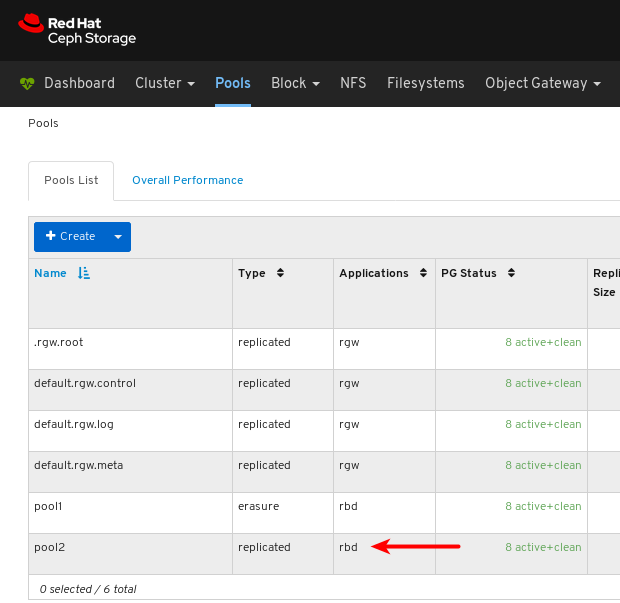

7.10. 管理池

作为存储管理员,您可以创建、删除和编辑池。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板

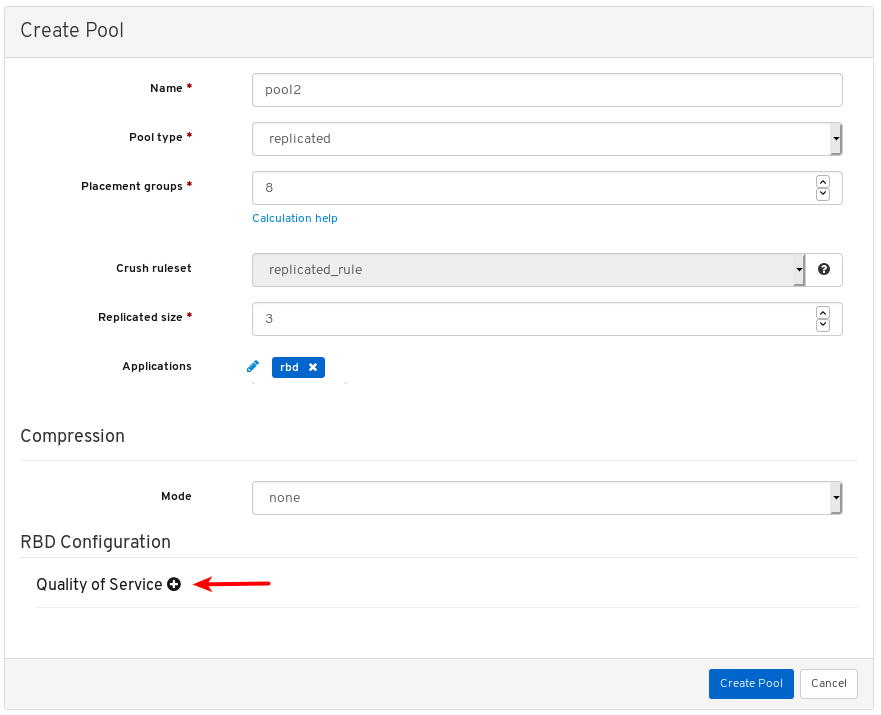

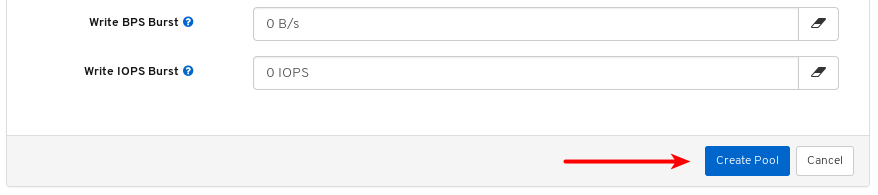

7.10.1. 创建池

您可以创建池来对存储对象进行逻辑分区。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

流程

- 登录控制面板。

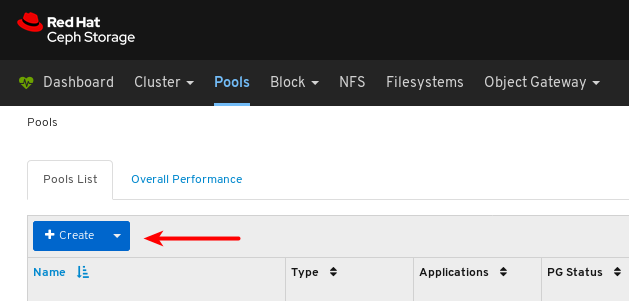

在导航栏中,单击 池。

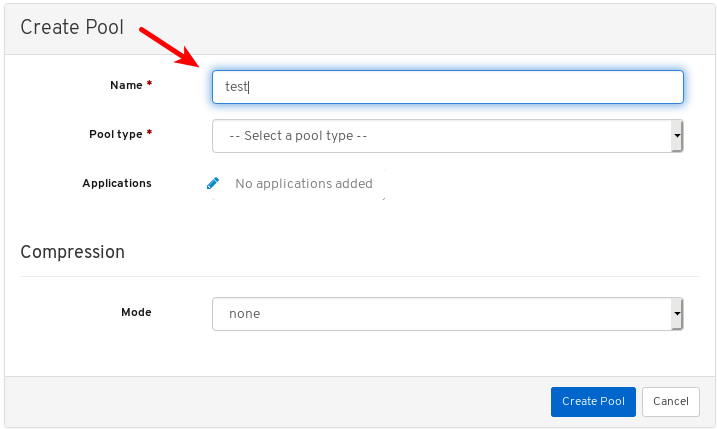

点击页面左上角的 Create 按钮。

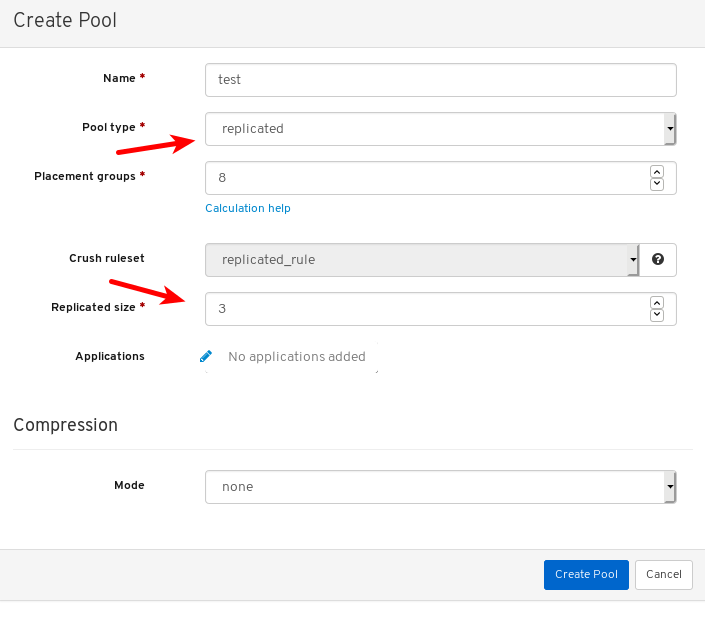

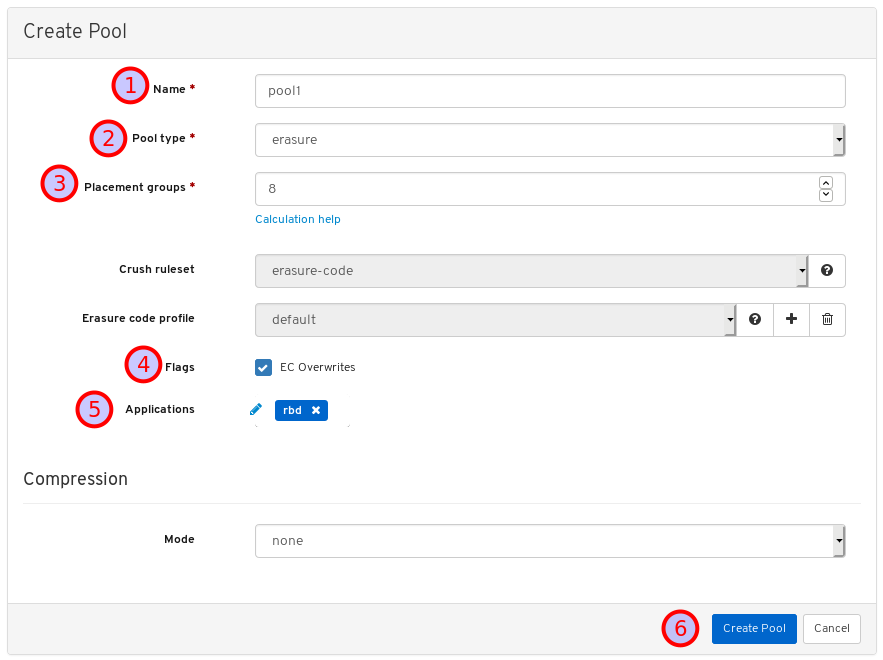

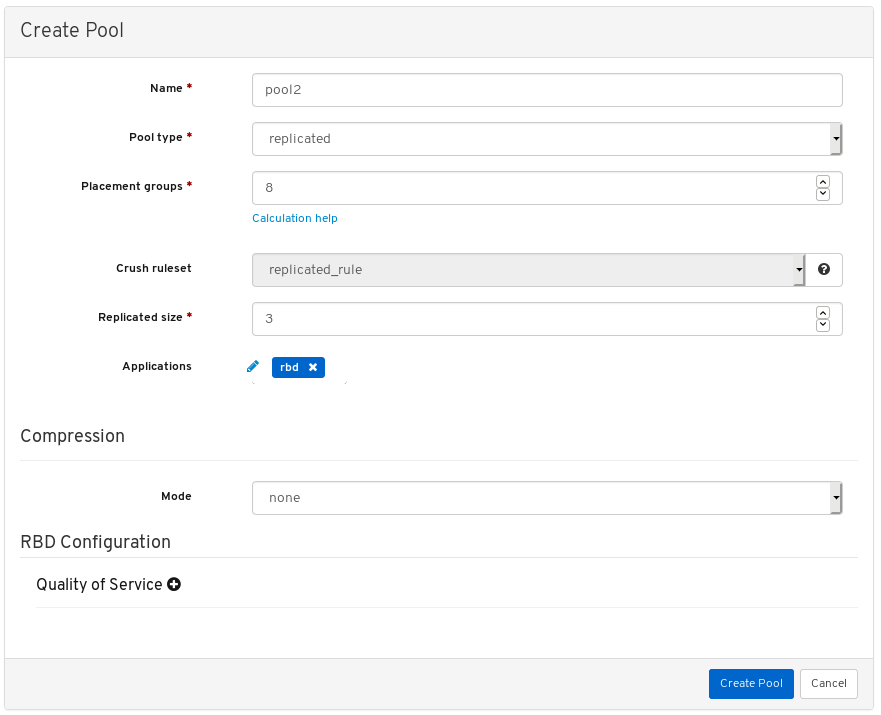

在对话窗口中,设置名称。

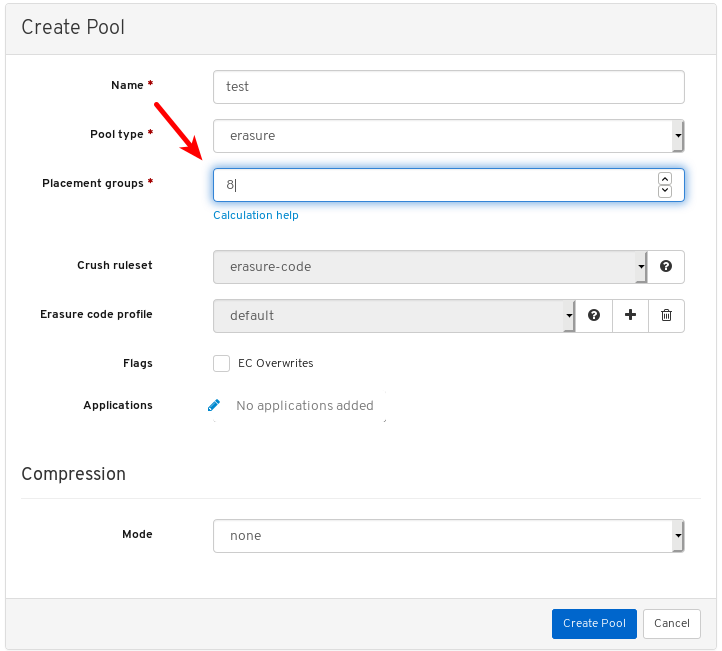

选择 replicated 或 Erasure Coded(EC)池类型。

设置放置组(PG)号。

可选:如果使用复制池类型,设置复制大小。

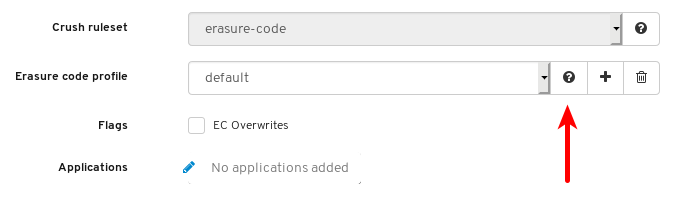

可选:如果使用 EC 池类型,请配置以下附加设置。

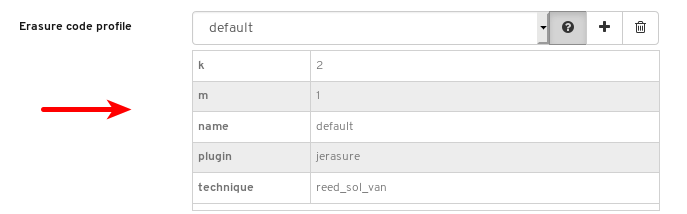

可选: 要查看当前选择的 EC 配置集的设置,请点击问题标记。

显示所选 EC 配置集的设置表。

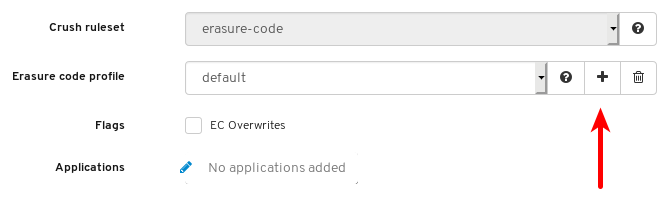

可选:点加号符号添加新 EC 配置集。

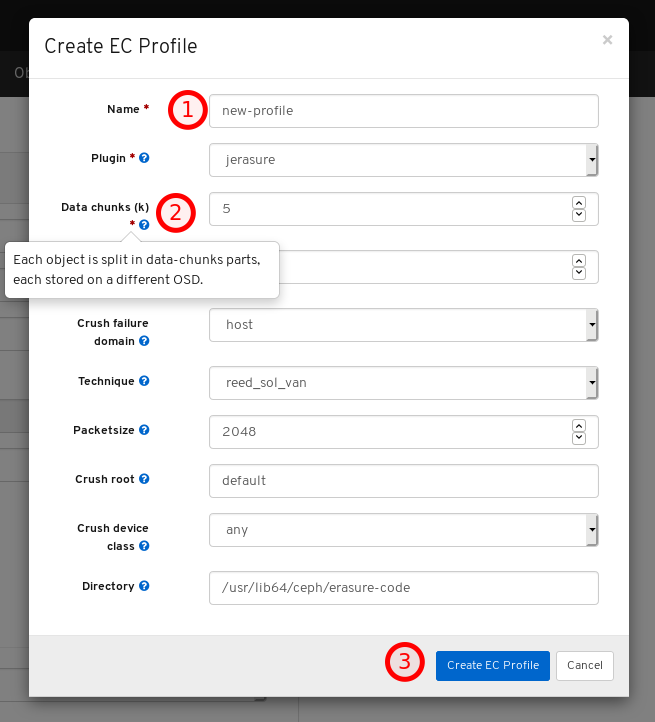

在 1 设置新 EC 配置集的名称,单击有关该设置的任何问号符号,并在修改所有必要设置后,单击 3。

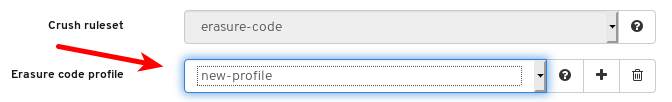

选择新的 EC 配置集。

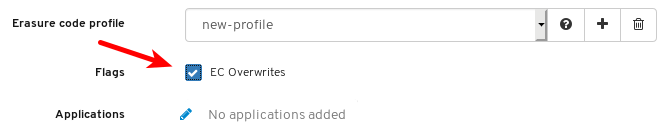

可选:如果需要 EC 覆盖,点其按钮。

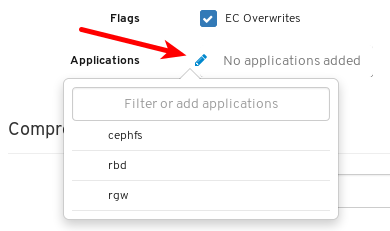

可选:点击铅笔图标为池选择应用程序。

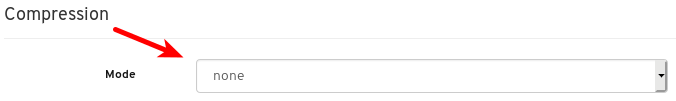

可选:如果需要压缩,请选择 passive, aggressive, 或 force。

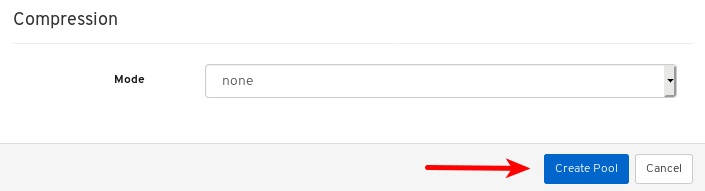

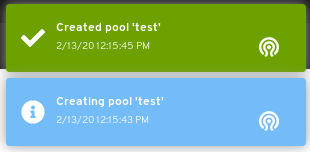

点 Create Pool 按钮。

对页面右上角的通知表示池已成功创建。

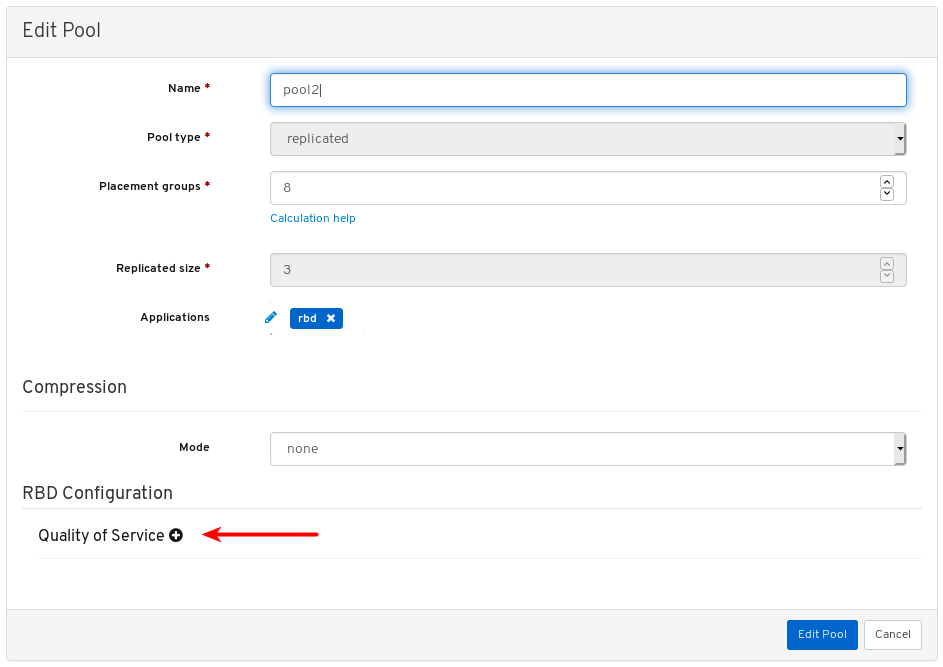

7.10.2. 编辑池

Red Hat Ceph Storage Dashboard 允许编辑池。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已创建一个池。

流程

- 登录控制面板。

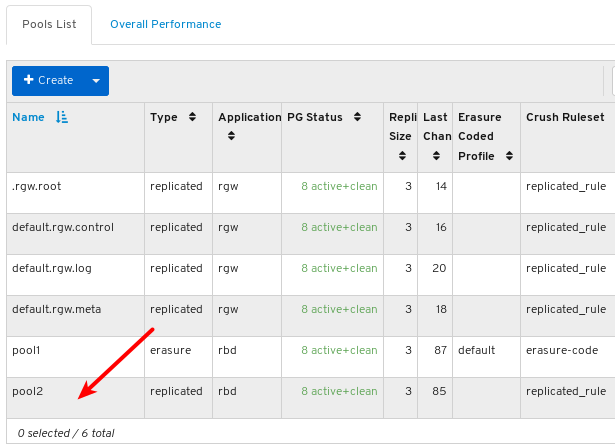

在导航栏中,单击 池。

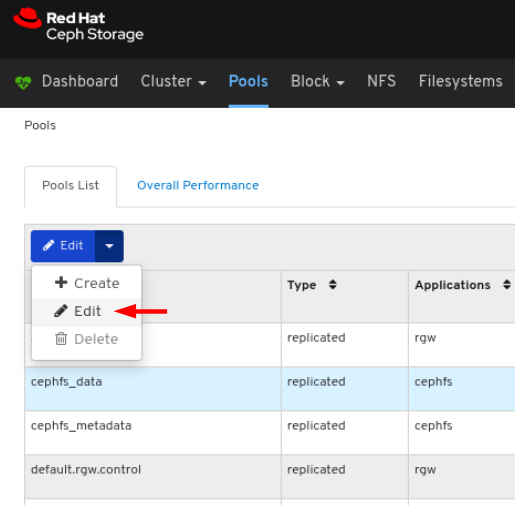

要编辑池,请点其行:

在 Edit 下拉菜单中选择 Edit:

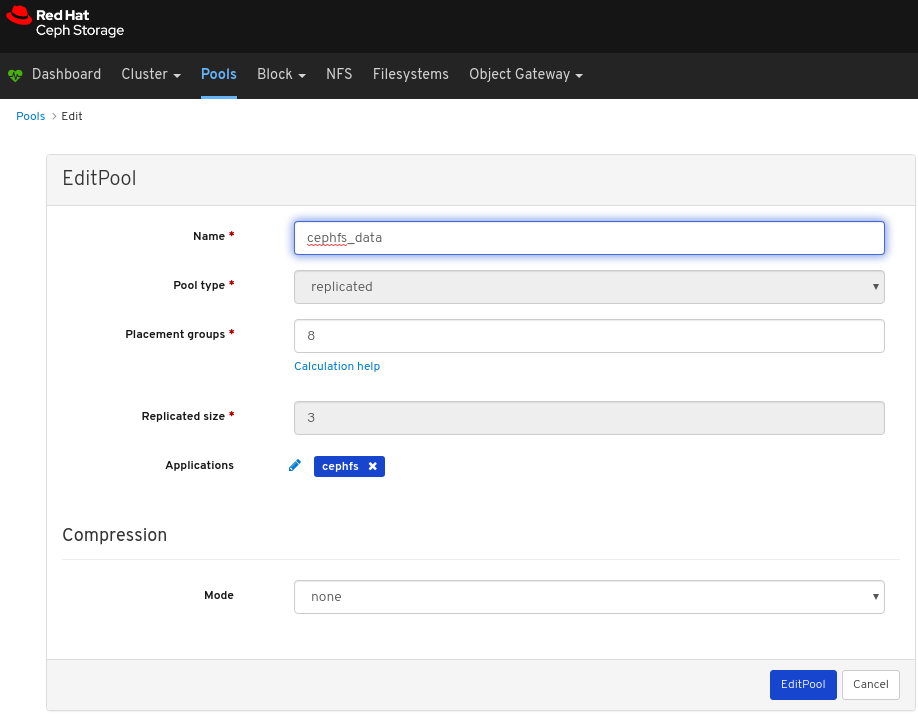

在对话窗口中,编辑所需参数,再单击 EditPool 按钮:

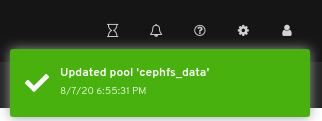

对页面右上角的通知表示池已被成功更新。

7.10.3. 删除池

Red Hat Ceph Storage Dashboard 允许删除池。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已创建一个池。

流程

- 登录控制面板。

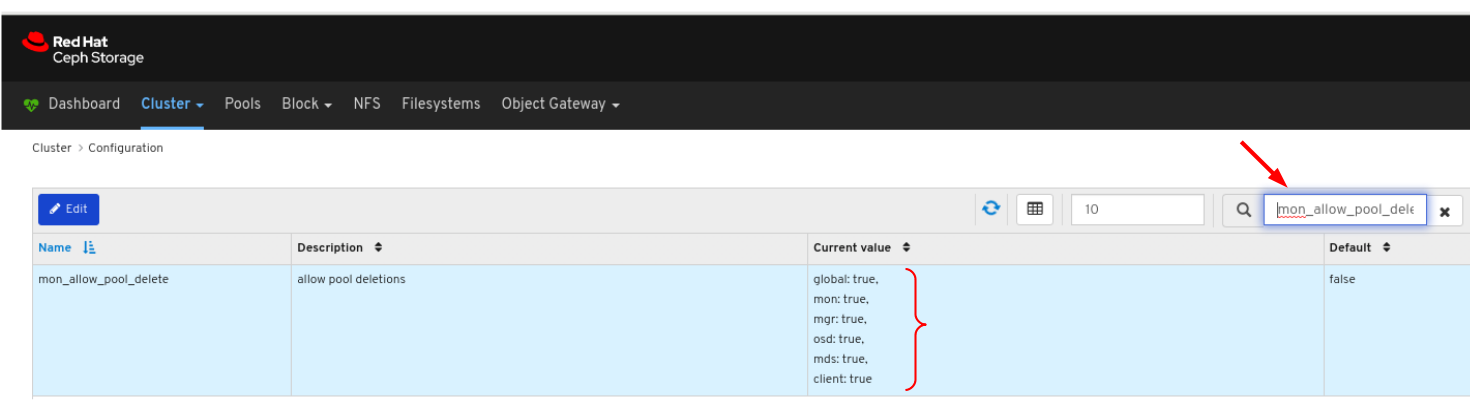

确保

mon_allow_pool_delete的值设置为true:- 在导航栏中,单击 Cluster,然后单击 Configuration。

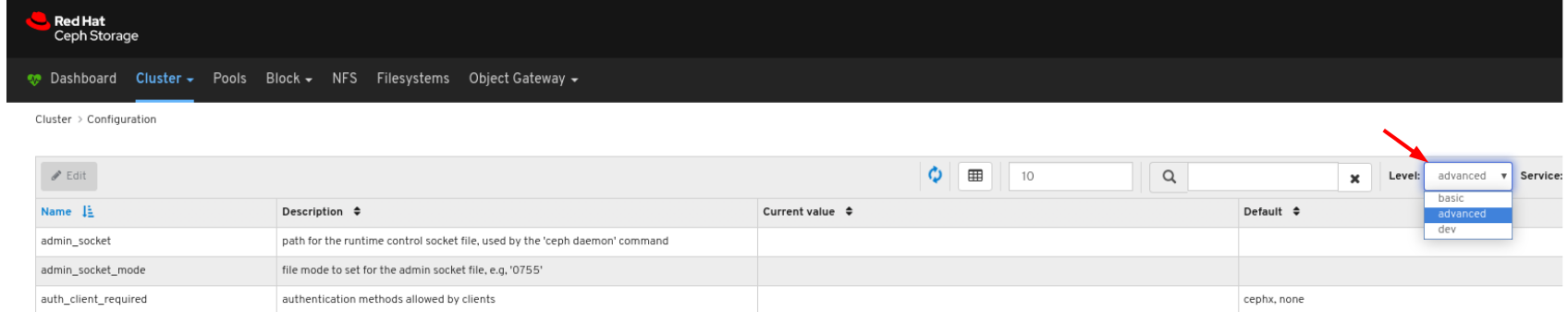

在 Level 下拉菜单中选择 Advanced:

搜索

mon_allow_pool_delete,并将值设为true

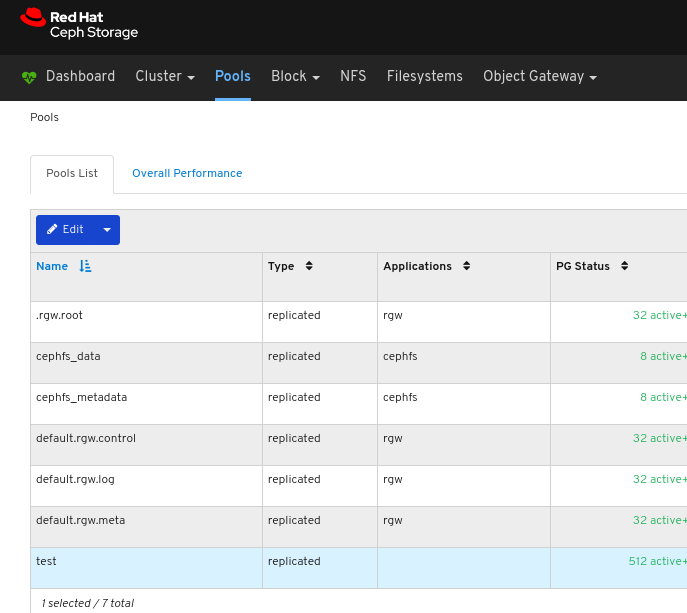

在导航栏中点 Pools :

要删除池,请点击其行:

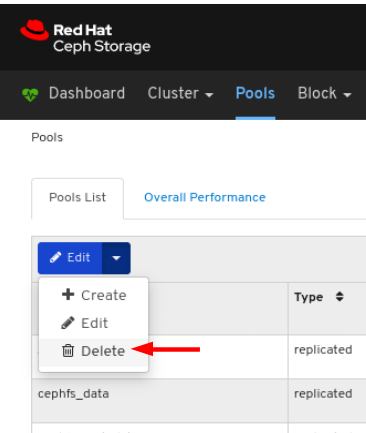

在 Edit 下拉列表中选择 Delete:

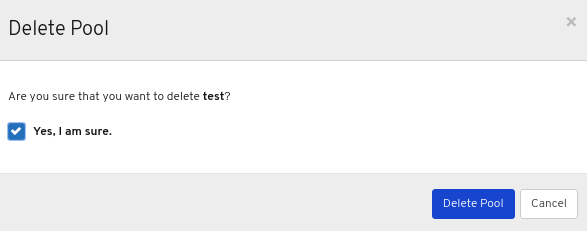

在 Delete Pool 对话框窗口中,单击 Yes,我确定 框,然后单击 Delete Pool 以保存设置:

对页面右上角的通知表示池已被成功删除。

第 8 章 对象网关

作为存储管理员,通过控制面板的对象网关功能,您可以管理和监控 Ceph 对象网关。

例如,监控功能允许您查看有关网关守护进程的详细信息,如其区域名称,或者 GET 和 PUT 速率的性能图形。通过管理功能,可以查看、创建和编辑用户和 bucket。

对象网关功能在守护进程功能、用户功能和 bucket 功能之间划分。

8.1. 先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph 对象网关。

8.2. 对象网关守护进程功能

作为存储管理员,Red Hat Ceph Storage 控制面板可以查看和监控 Ceph 对象网关守护进程的信息。

8.2.1. 先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph 对象网关。

- 对象网关登录凭据添加到仪表板中。

8.2.2. 查看对象网关守护进程

通过控制面板,您可以查看所有 Ceph 对象网关守护进程的列表。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph 对象网关。

- 对象网关登录凭据添加到仪表板中。

流程

- 登录到仪表板。

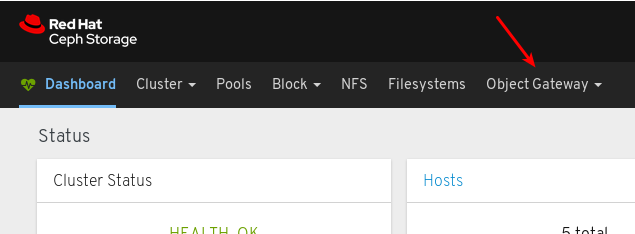

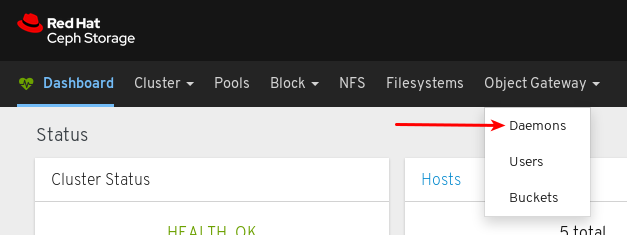

在导航栏中,单击 Object Gateway。

单击 Daemons。

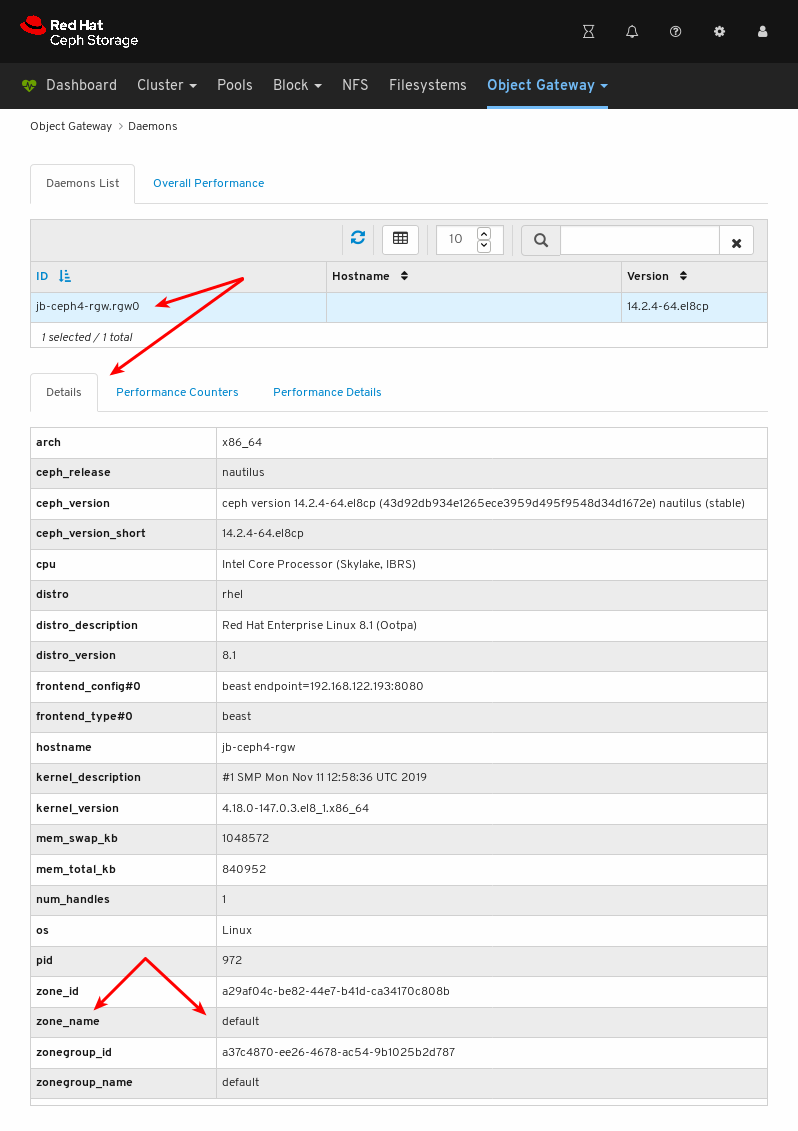

在以下示例中,您可以在 Daemons List 中看到 ID 为

jb-ceph4-rgw.rgw0的守护进程。要查看详情,请点击

jb-ceph4-rgw.rgw0的行来选择守护进程:您可以看到后台程序正在提供的区域名称

是默认的。

其它资源

- 有关如何安装 Ceph 对象网关的详情,请参考 《安装指南》 中的 安装 Ceph 对象网关。

- 有关如何将对象网关登录凭证添加到仪表板中的信息,请参阅 控制面板指南中的 将对象 网关登录凭证添加到仪表板中。

8.3. 对象网关用户功能

作为存储管理员,Red Hat Ceph Storage 控制面板可以查看和管理 Ceph 对象网关用户。

8.3.1. 先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph 对象网关。

- 对象网关登录凭据添加到仪表板中。

8.3.2. 查看对象网关用户

通过控制面板,您可以查看所有 Ceph 对象网关用户的列表。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph 对象网关。

- 对象网关登录凭据添加到仪表板中。

流程

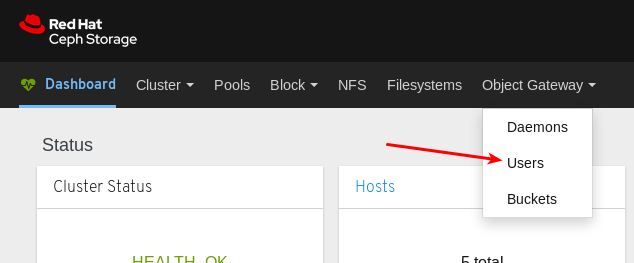

- 登录到仪表板。

在导航栏中,单击 Object Gateway。

点 Users。

在以下示例中,您可以在表中看到名为

rgw-user的用户。要查看详情,请点击

rgw-user所在的行来选择用户:

其它资源

- 有关如何安装 Ceph 对象网关的详情,请参考 《安装指南》 中的 安装 Ceph 对象网关。

- 有关如何将对象网关登录凭证添加到仪表板中的信息,请参阅 控制面板指南中的 将对象 网关登录凭证添加到仪表板中。

- 如需有关 Ceph 对象网关的更多信息,请参阅《 对象网关配置和管理指南》。

8.3.3. 创建对象网关用户

控制面板允许您创建 Ceph 对象网关用户。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph 对象网关。

- 对象网关登录凭据添加到仪表板中。

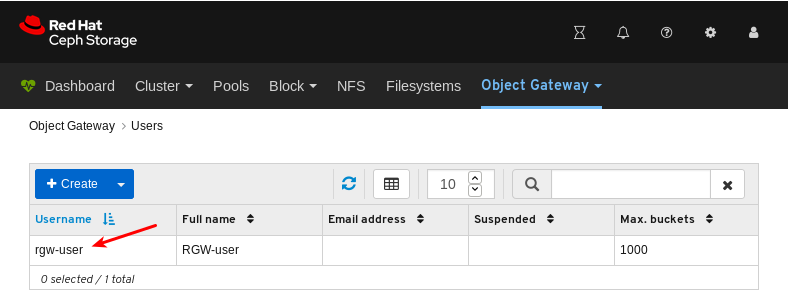

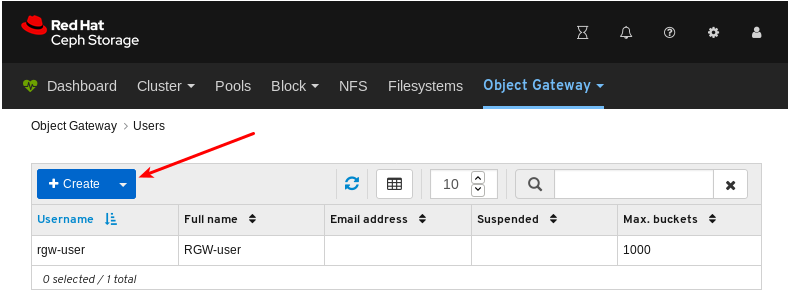

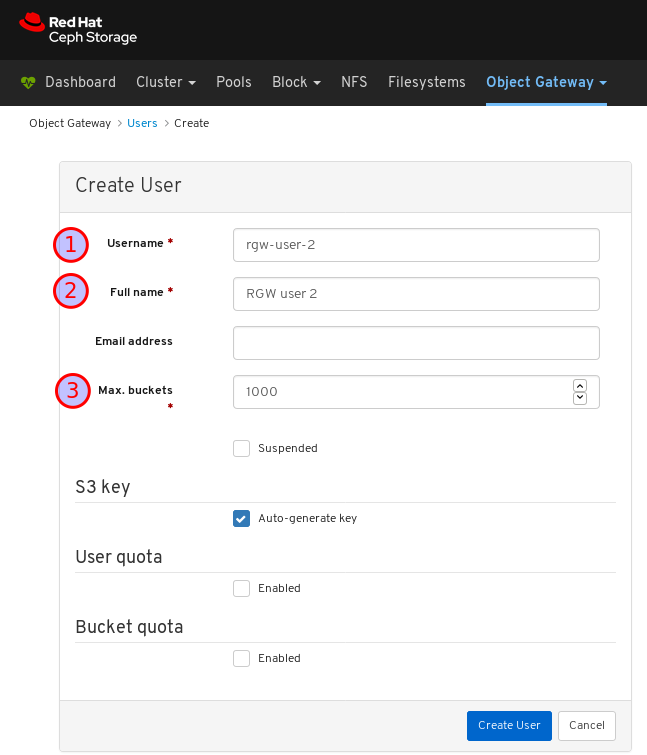

流程

- 登录到仪表板。

在导航栏中,单击 Object Gateway。

点 Users。

点击 Create。

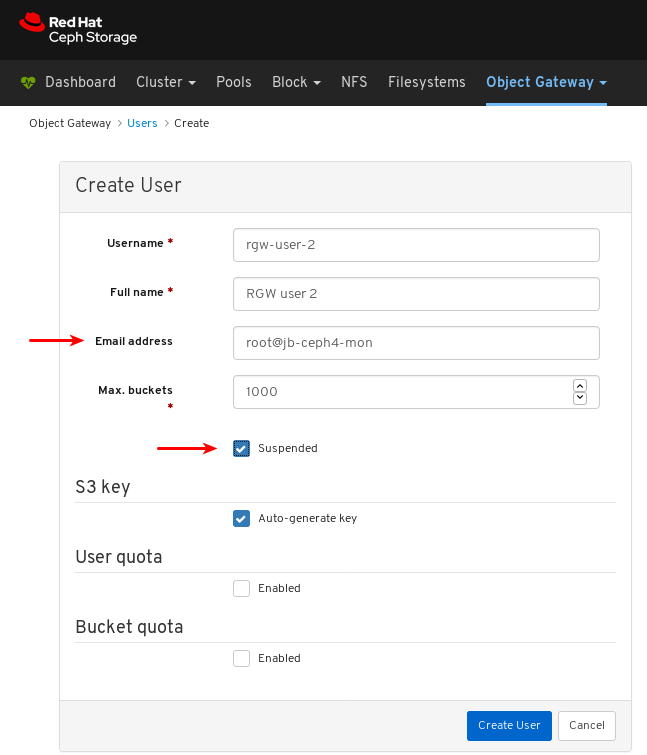

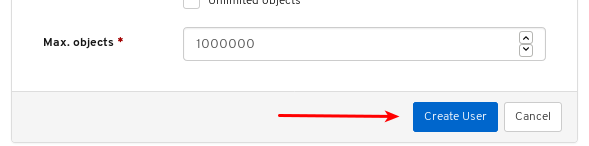

设置用户名、全名,并根据需要编辑 bucket 的最大数量。

可选:设置电子邮件地址或挂起状态。

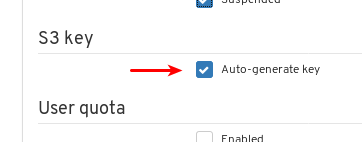

可选:通过取消选中 Auto-generate key 来设置自定义 access key 和 secret key。

取消选中 Auto-generate 键 :

设置 access key 和 secret 密钥:

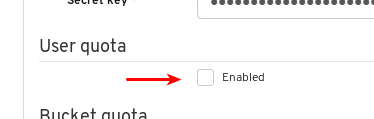

可选:设置用户配额。

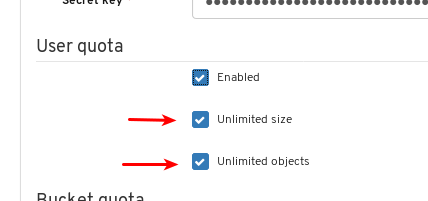

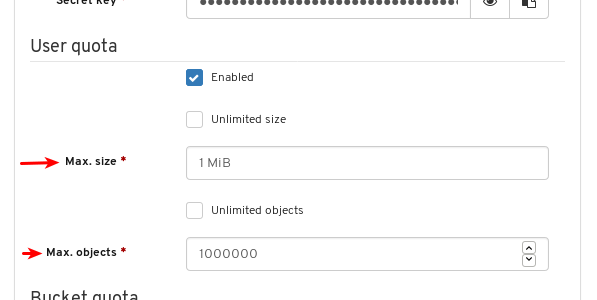

在 User quota 下选中 Enabled :

取消选择 Unlimited size 或 Unlimited objects:

为 Max. size 或 Max. objects 输入所需的值:

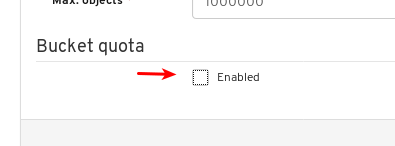

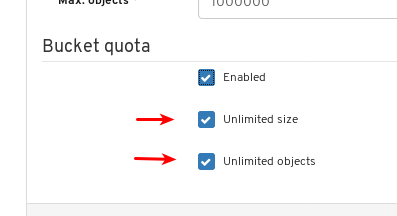

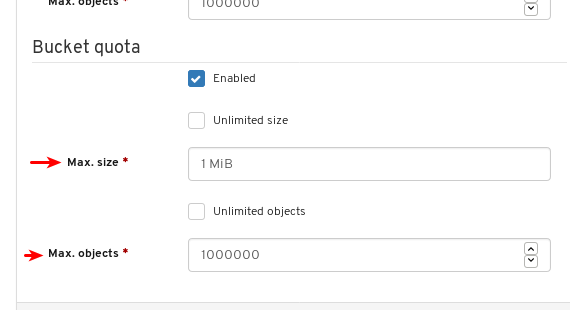

可选:设置存储桶配额。

在 Bucket 配额下选中 已启用 :

取消选择 Unlimited size 或 Unlimited objects:

为 Max. size 或 Max. objects 输入所需的值:

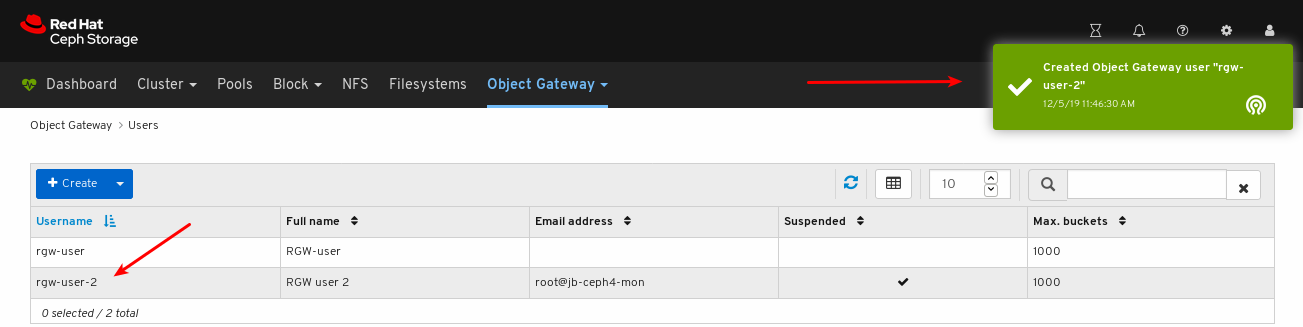

单击 创建用户 来完成用户创建。

验证用户创建是否成功。通知确认用户已创建,用户可以在用户表中看到。

其它资源

- 有关如何安装 Ceph 对象网关的详情,请参考 《安装指南》 中的 安装 Ceph 对象网关。

- 有关如何将对象网关登录凭证添加到仪表板中的信息,请参阅 控制面板指南中的 将对象 网关登录凭证添加到仪表板中。

- 如需有关 Ceph 对象网关的更多信息,请参阅《 对象网关配置和管理指南》。

8.3.4. 编辑对象网关用户

通过控制面板,您可以编辑 Ceph 对象网关用户。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph 对象网关。

- 对象网关登录凭据添加到仪表板中。

- 已创建 Ceph 对象网关用户。

流程

- 登录到仪表板。

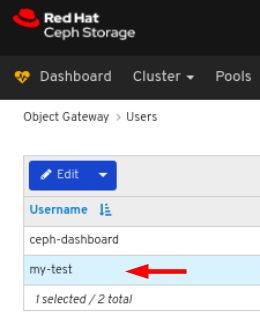

在导航栏中,单击 Object Gateway :

点 Users:

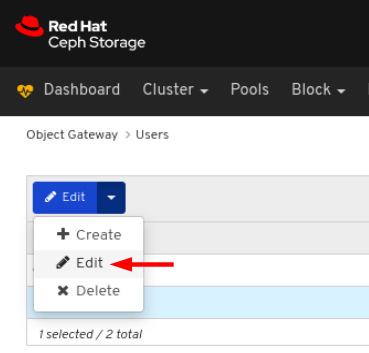

要编辑用户功能,请点其行:

在 Edit 下拉菜单中选择 Edit:

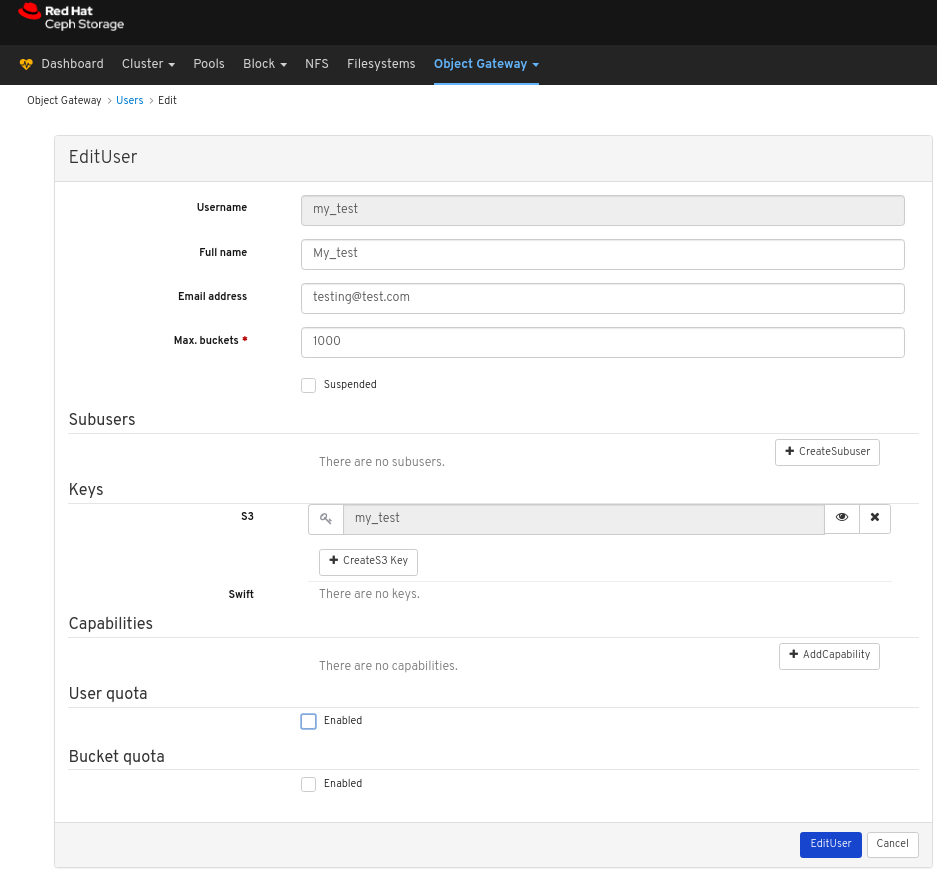

在 EditUser 窗口中,编辑所需的参数并点 EditUser 按钮:

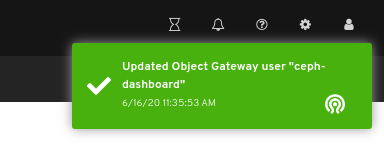

对页面右上角的通知表示用户已被成功更新。

8.3.5. 删除对象网关用户

通过控制面板,您可以删除 Ceph 对象网关用户。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph 对象网关。

- 对象网关登录凭据添加到仪表板中。

- 已创建 Ceph 对象网关用户。

流程

- 登录到仪表板。

在导航栏中,单击 Object Gateway :

点 Users:

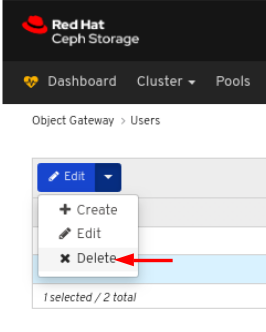

要删除用户,请点其行:

在 Edit 下拉菜单中选择 Delete:

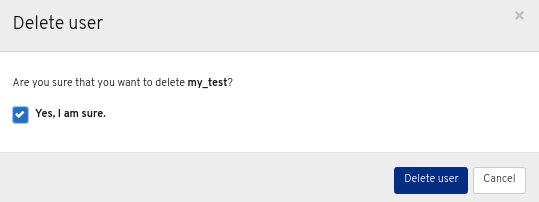

在 Delete User 对话框中,单击 Yes,我确定 框,然后单击 Delete User 以保存设置:

8.3.6. 创建对象网关子用户

子用户与 S3 界面的用户关联。控制面板允许您创建 Ceph 对象网关子用户。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph 对象网关。

- 对象网关登录凭据添加到仪表板中。

- 已创建对象网关用户。

流程

- 登录到仪表板。

在导航栏中,单击 Object Gateway。

从下拉菜单中选择 Users。

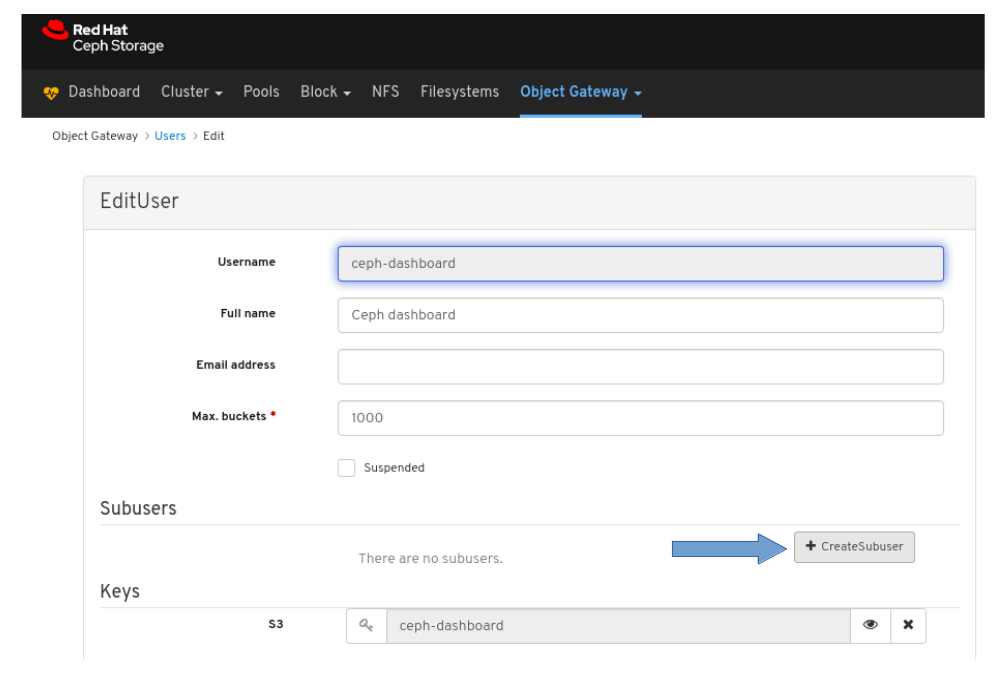

在以下示例中,您可以在表中看到名为

ceph-dashboard的用户。单击用户行来选择用户。单击 Edit 下拉菜单,然后选择 Edit。

单击 +CreateSubuser 按钮。

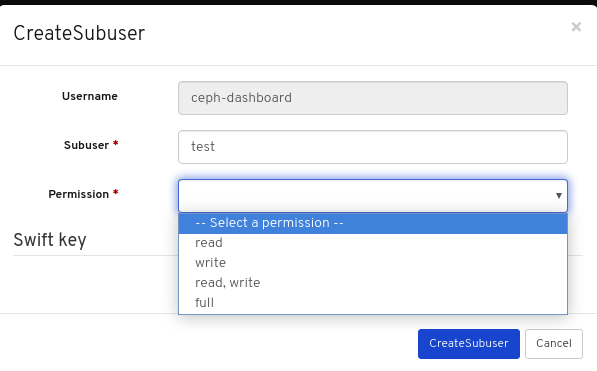

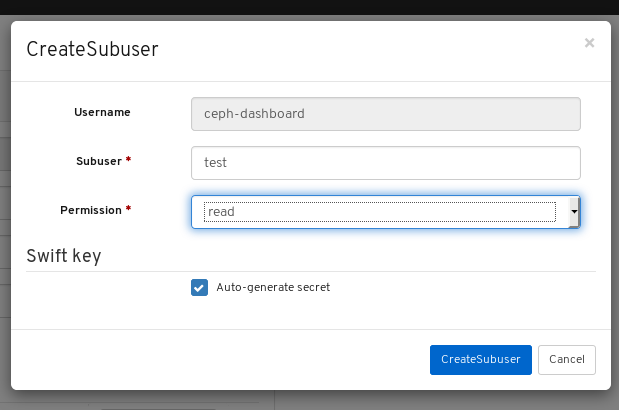

输入 子用户名 并选择相应的权限。

单击 Auto-generate secret 框,然后单击 Create Subuser 按钮。

注意通过单击 Auto-generate-secret 复选框,会自动生成对象网关的机密密钥。

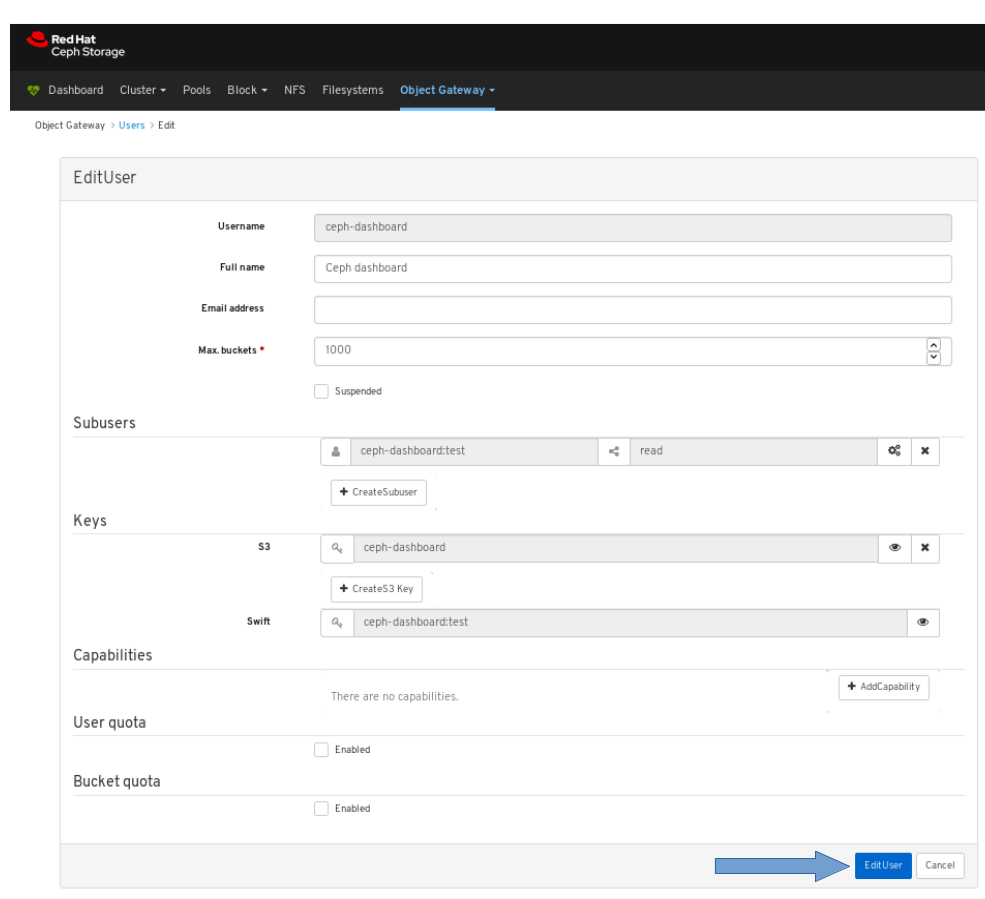

在 Edit User 窗口中,单击 Edit user 按钮。

验证子用户创建是否成功。弹出了显示对象网关用户已成功更新页面右上角的通知。

其它资源

- 有关如何安装 Ceph 对象网关的详情,请参考 Red Hat Ceph Storage 安装指南 中的安装 Ceph 对象网关。

- 有关如何手动将对象网关登录凭证添加到仪表板中,请参阅控制面板中 手动将对象网关登录凭证添加到仪表板中。https://access.redhat.com/documentation/en-us/red_hat_ceph_storage/4/html-single/dashboard_guide/

- 如需有关 Ceph 对象网关的更多信息,请参阅《 对象网关配置和管理指南》。

8.4. 对象网关存储桶功能

作为存储管理员,Red Hat Ceph Storage 控制面板可以查看和管理 Ceph 对象网关 bucket。

8.4.1. 先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph 对象网关。

- 对象网关登录凭据添加到仪表板中。

8.4.2. 查看对象网关存储桶

控制面板允许您查看和管理 Ceph 对象网关 bucket。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph 对象网关。

- 对象网关登录凭据添加到仪表板中。

- 已创建一个对象网关 bucket。

流程

- 登录到仪表板。

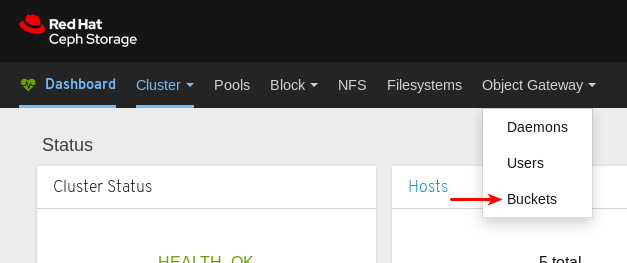

在导航栏中,单击 Object Gateway。

点 Buckets。

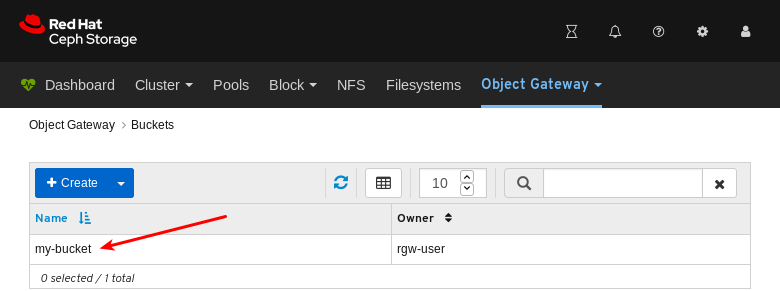

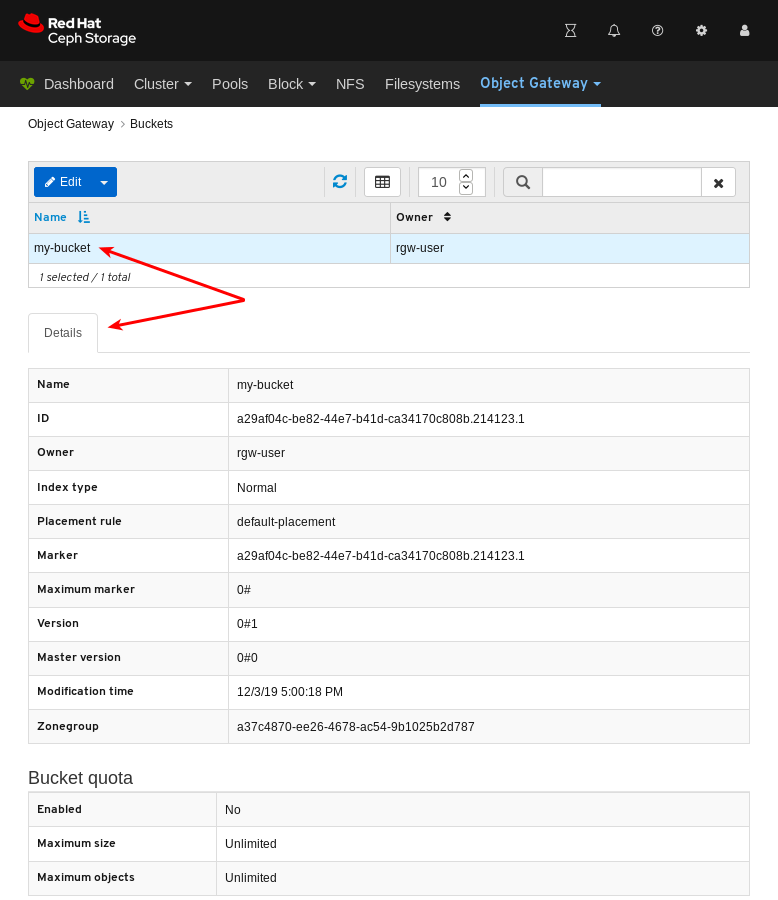

在以下示例中,您可以在表中看到名为

my-bucket的存储桶。若要查看详细信息,可单击

my-bucket所在的行,以选择存储桶。

其它资源

- 有关如何安装 Ceph 对象网关的详情,请参考 《安装指南》 中的 安装 Ceph 对象网关。

- 有关如何将对象网关登录凭证添加到仪表板中的信息,请参阅 控制面板指南中的 将对象 网关登录凭证添加到仪表板中。

- 如需有关 Ceph 对象网关的更多信息,请参阅《 对象网关配置和管理指南》。

8.4.3. 创建对象网关存储桶

控制面板允许您创建 Ceph 对象网关 bucket。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph 对象网关。

- 对象网关登录凭据添加到仪表板中。

- 创建未暂停的对象网关用户。

流程

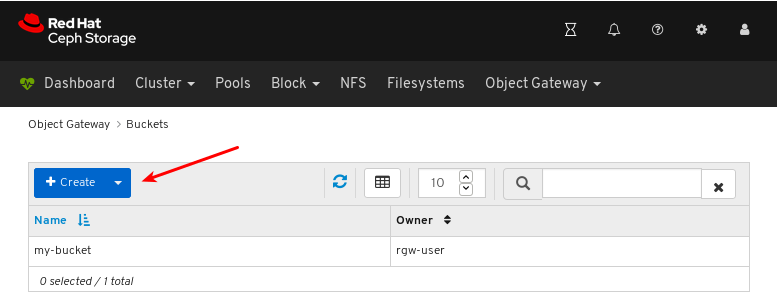

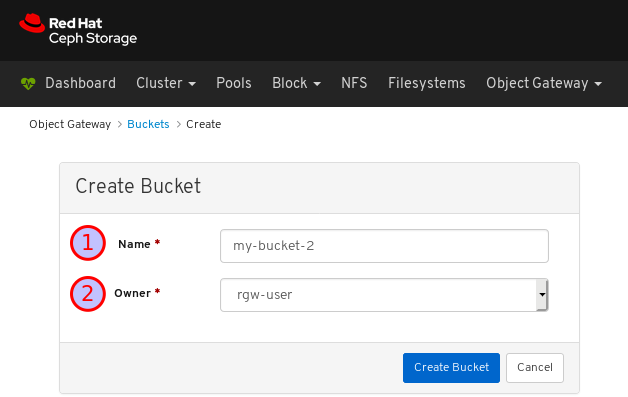

- 登录到仪表板。

在导航栏中,单击 Object Gateway。

点 Buckets。

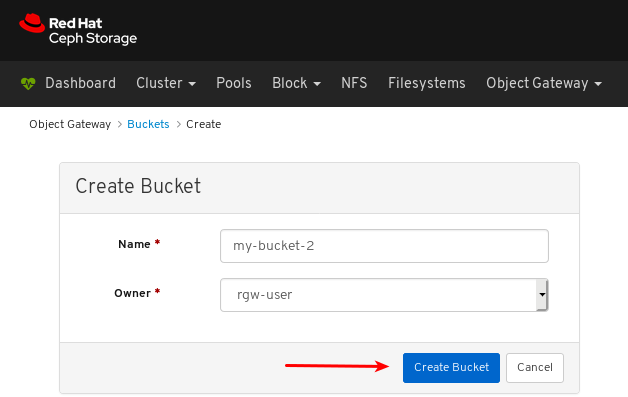

点击 Create。

为 Name 输入值并选择没有暂停的用户。

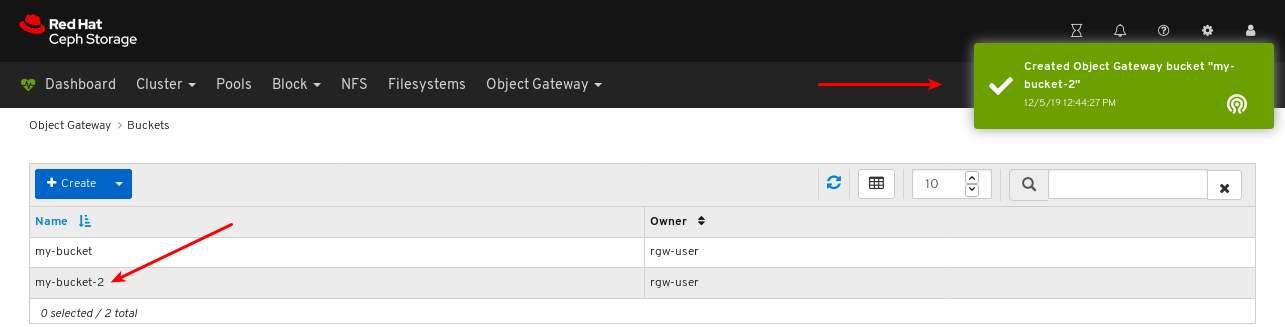

点 Create bucket。

验证 bucket 创建是否成功。通知确认已创建存储桶,并且可以在 bucket 表中看到 bucket。

其它资源

- 有关如何安装 Ceph 对象网关的详情,请参考 《安装指南》 中的 安装 Ceph 对象网关。

- 有关如何将对象网关登录凭证添加到仪表板中的信息,请参阅 控制面板指南中的 将对象 网关登录凭证添加到仪表板中。

- 如需有关 Ceph 对象网关的更多信息,请参阅《 对象网关配置和管理指南》。

8.4.4. 编辑对象网关存储桶

通过控制面板,您可以编辑 Ceph 对象网关 bucket。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph 对象网关。

- 对象网关登录凭据添加到仪表板中。

- 创建未暂停的 Ceph 对象网关用户。

- 已创建 Ceph 对象网关 bucket。

流程

- 登录到仪表板。

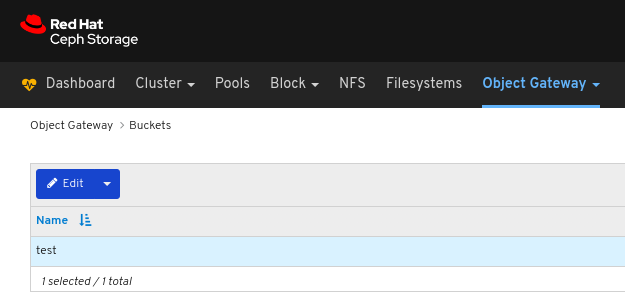

在导航栏中,单击 Object Gateway :

点击 Buckets :

要编辑存储桶,请点其行:

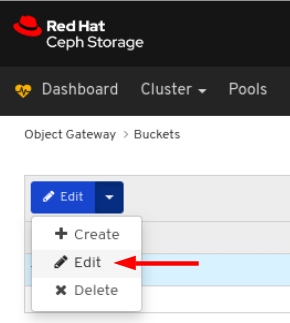

在 Edit 下拉菜单中选择 Edit:

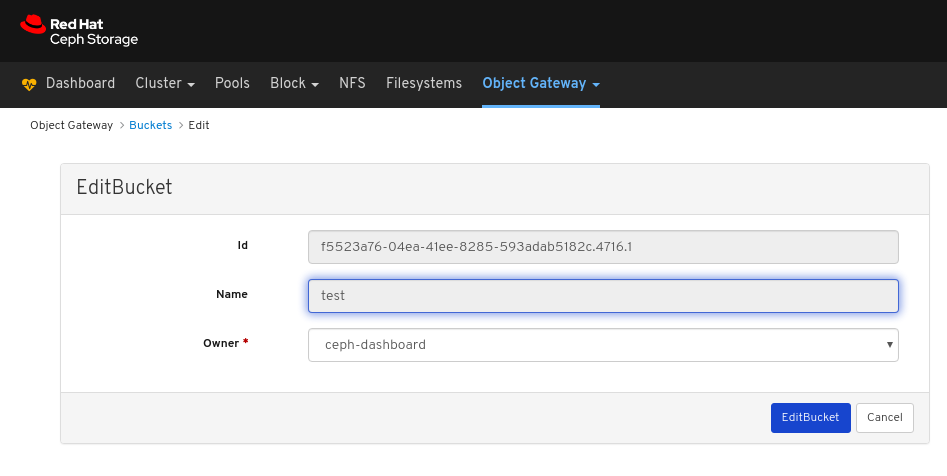

在 EditBucket 窗口中,编辑所需的参数并点 EditBucket 按钮:

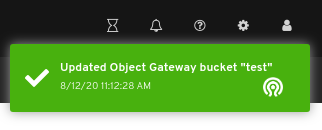

对页面右上角的通知表示已成功更新存储桶。

其它资源

- 如需更多信息,请参阅 Red Hat Ceph Storage 安装指南中的安装 Ceph对象网关 部分。

- 如需更多信息,请参阅 Red Hat Ceph Storage Dashboard 指南中的 将对象网关登录凭证添加到仪表板 部分。

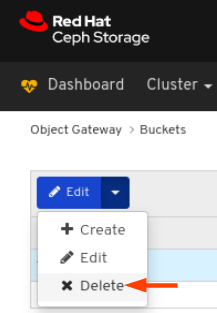

8.4.5. 删除对象网关存储桶

通过控制面板,您可以删除 Ceph 对象网关 bucket。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph 对象网关。

- 对象网关登录凭据添加到仪表板中。

- 创建未暂停的 Ceph 对象网关用户。

- 已创建 Ceph 对象网关 bucket。

流程

- 登录到仪表板。

在导航栏中,单击 Object Gateway :

点击 Buckets :

要删除存储桶,请点其行:

在 Edit 下拉菜单中选择 Delete:

在 Delete Bucket 对话框中,点击 Yes,我确定 框,然后单击 Delete bucket 以保存设置:

8.5. 在仪表板中手动添加对象网关登录凭证

Red Hat Ceph Storage 控制面板可以管理 Ceph 对象网关,也称为 RADOS 网关或 RGW。若要管理 Ceph 对象网关,控制面板必须使用具有 系统 标志的 RGW 用户的登录凭据来连接它。使用 ceph-ansible 安装对象网关时,它会自动将登录凭据添加到仪表板中。也可以手动设置登录凭据。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph 对象网关。

流程

获取 RGW 用户的

access_key和secret_key启用了系统标志:如果您没有启用 RGW 用户且启用了

系统标志,请创建一个。radosgw-admin user create --uid=USER_ID --display-name=DISPLAY_NAME --system

radosgw-admin user create --uid=USER_ID --display-name=DISPLAY_NAME --systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 记录

access_key和secret_key的值。在上例中,access_key是BYC5SWQH24A2BFHS2RC和secret_key是159d94uHK9ADiWZrGsNYWXCDrhL2xVi8PO6kT。如果已创建了启用了

系统标志的 RGW 用户,则使用radosgw-admin实用程序的用户 info命令获取凭据。radosgw-admin user info --uid=USER_ID

radosgw-admin user info --uid=USER_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 记录

access_key和secret_key的值。在上例中,access_key是BYC5SWQH24A2BFHS2RC和secret_key是159d94uHK9ADiWZrGsNYWXCDrhL2xVi8PO6kT。

为仪表板提供

access_key和secret_key凭证:为控制面板提供

access_key。ceph dashboard set-rgw-api-access-key ACCESS_KEY

ceph dashboard set-rgw-api-access-key ACCESS_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

ceph dashboard set-rgw-api-access-key BYC5SWQQH24A2BFHS2RC

[root@mon ~]# ceph dashboard set-rgw-api-access-key BYC5SWQQH24A2BFHS2RC Option RGW_API_ACCESS_KEY updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将

secret_key提供到控制面板。ceph dashboard set-rgw-api-secret-key SECRET_KEY

ceph dashboard set-rgw-api-secret-key SECRET_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

ceph dashboard set-rgw-api-secret-key 159d94uHK9ADiWZrGsNYWYjRXCDrhL2xVi8PO6kT

[root@mon ~]# ceph dashboard set-rgw-api-secret-key 159d94uHK9ADiWZrGsNYWYjRXCDrhL2xVi8PO6kT Option RGW_API_SECRET_KEY updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

为控制面板提供对象网关的主机名和端口:

将主机名提供给仪表板。

ceph dashboard set-rgw-api-host HOST_NAME

ceph dashboard set-rgw-api-host HOST_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

ceph dashboard set-rgw-api-host 192.168.122.193

[root@mon ~]# ceph dashboard set-rgw-api-host 192.168.122.193 Option RGW_API_HOST updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将端口提供给控制面板。

ceph dashboard set-rgw-api-port PORT

ceph dashboard set-rgw-api-port PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

ceph dashboard set-rgw-api-port 8080

[root@mon ~]# ceph dashboard set-rgw-api-port 8080 Option RGW_API_PORT updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

可选: 如果您使用带有自签名证书的 HTTPS,在仪表板中禁用证书验证以避免拒绝的连接。

当证书由未知证书颁发机构签名,或者使用的主机名与证书中的主机名不匹配时,可能会发生拒绝的连接。

ceph dashboard set-rgw-api-ssl-verify false

ceph dashboard set-rgw-api-ssl-verify falseCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

ceph dashboard set-rgw-api-ssl-verify false

[root@mon ~]# ceph dashboard set-rgw-api-ssl-verify false Option RGW_API_SSL_VERIFY updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

其它资源

- 有关如何安装 Ceph 对象网关的详情,请参考 《安装指南》 中的 安装 Ceph 对象网关。

- 如需有关 Ceph 对象网关的更多信息,请参阅《 对象网关配置和管理指南》。

第 9 章 块设备

9.1. 块设备简介

仪表板的块设备功能允许您管理和监控块设备镜像。该功能划分到通用镜像功能、镜像功能、iSCSI 功能和服务质量配置之间。例如,您可以创建新镜像,查看集群中镜像的镜像状态,管理或监控 iSCSI 目标,以及设置镜像的 IOPS 限制。

9.2. 镜像功能

控制面板提供了几种与管理和监控镜像相关的功能。

9.2.1. 先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

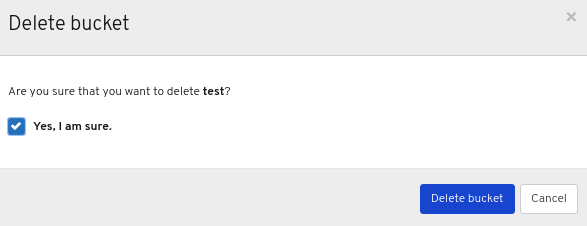

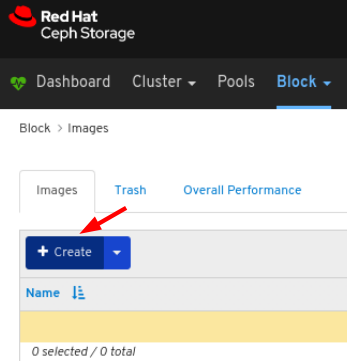

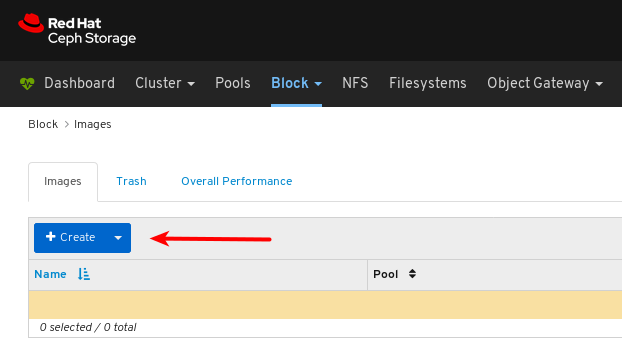

9.2.2. 创建镜像

仪表板允许您创建镜像。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

流程

- 登录到仪表板。

在导航栏中,点 Block :

从下拉菜单中选择 Images :

在 Images 选项卡中,点击 Create 按钮:

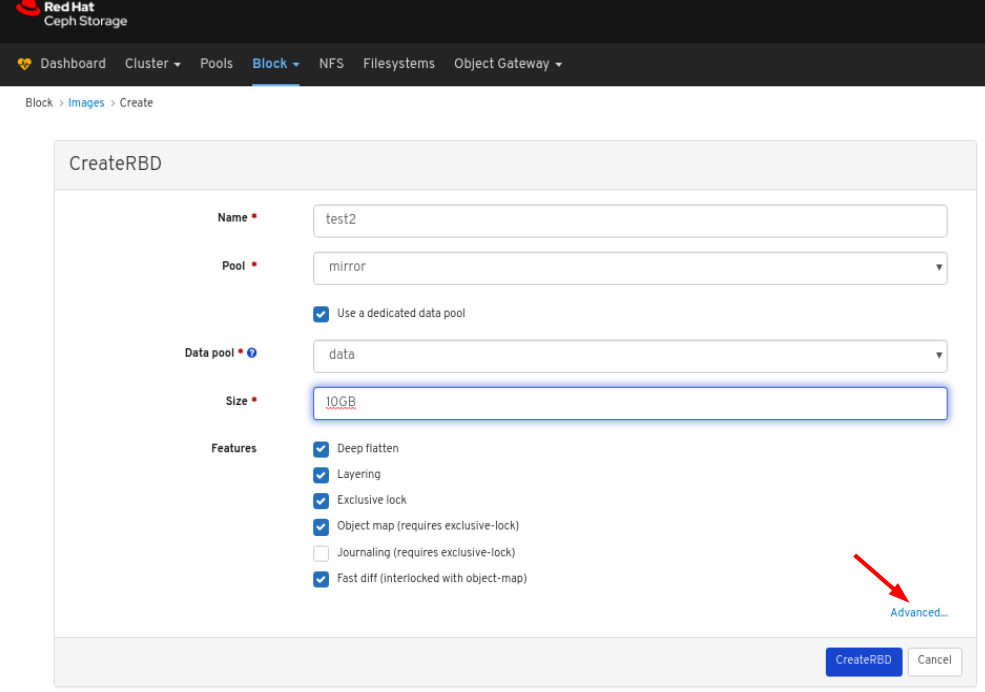

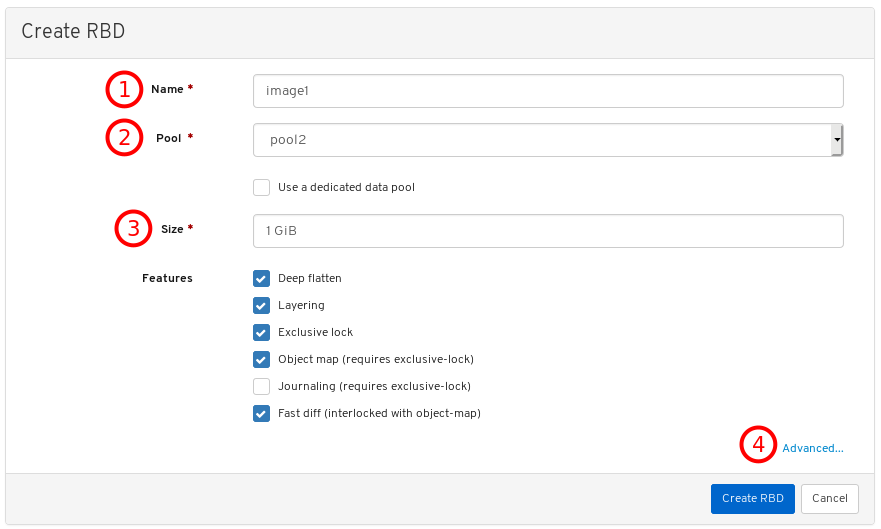

在 CreateRBD 窗口中输入参数:

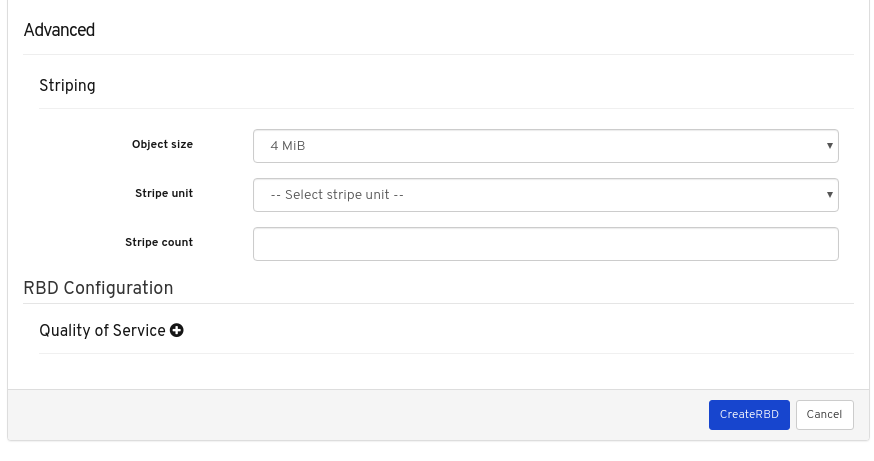

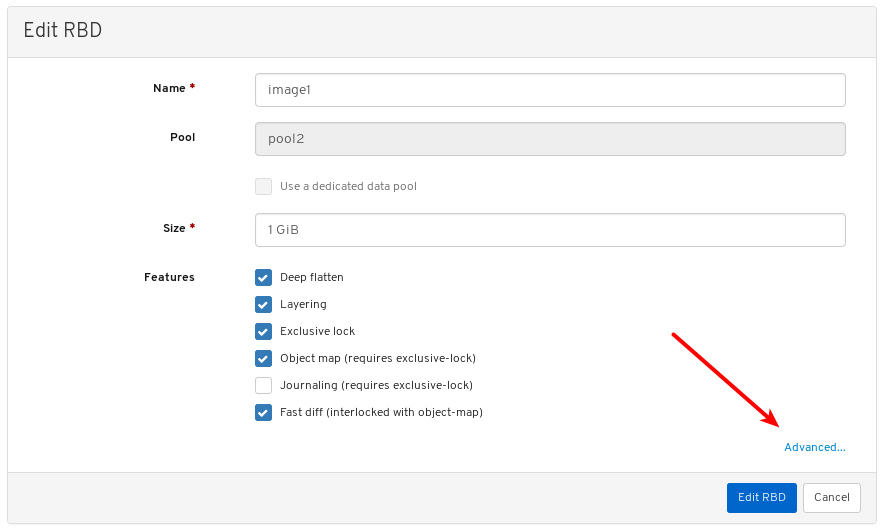

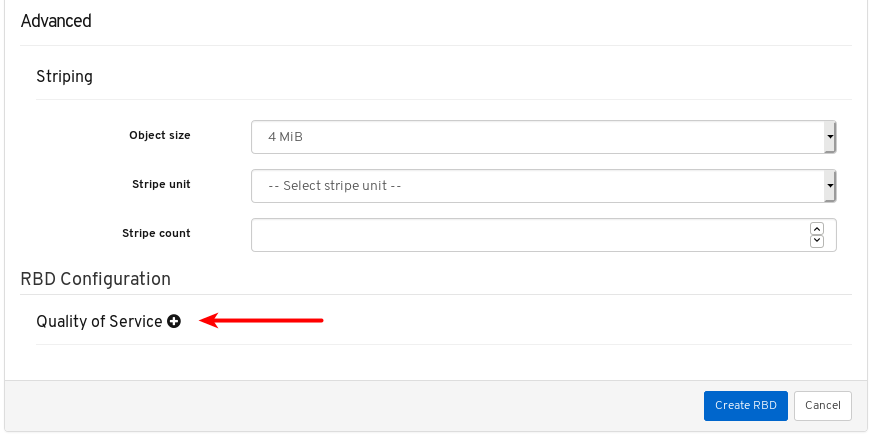

可选:点 Advanced 并设置参数:

单击 CreateRBD 按钮:

页面右上角发出的通知表示镜像已创建成功。

其它资源

- 有关镜像的更多信息,请参阅 Red Hat Ceph Storage Block Device Guide。

- 如需了解更多与创建 RBD 池的详细信息,请参阅 Red Hat Ceph Storage Dashboard Guide 中的创建池部分。

9.2.3. 查看镜像

仪表板允许您查看镜像。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 镜像在集群中。

流程

- 登录到仪表板。

- 在导航栏中,单击 Block。

点 Images :

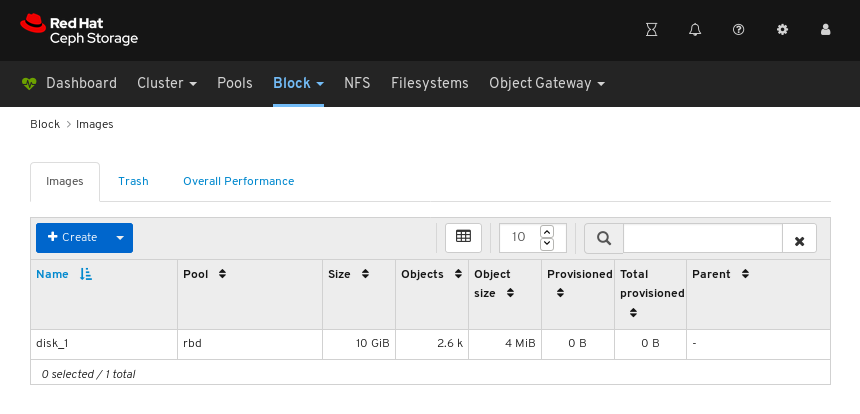

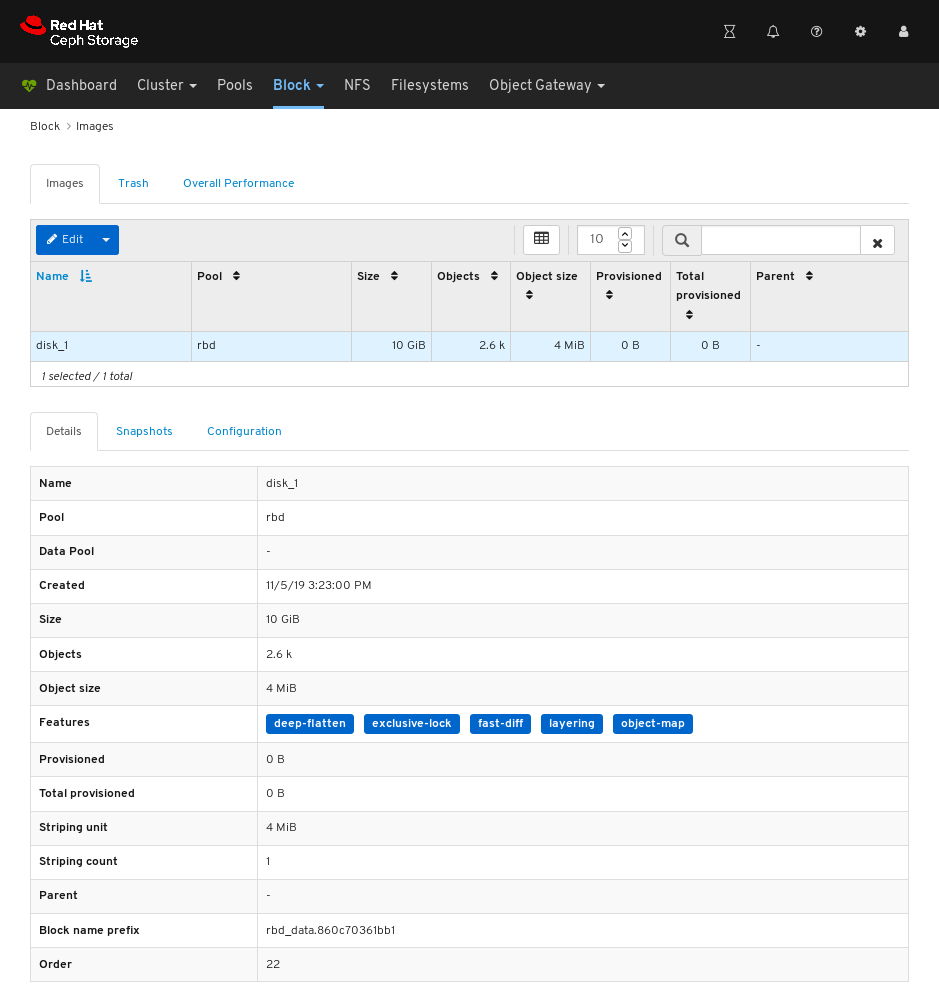

在上例中,您可以看到一个名为 disk_1 的 10 GiB 镜像。

要查看详情,请点击 disk_1 所在的行来选择镜像:

其它资源

- 有关镜像的更多信息,请参阅 块设备指南。

9.2.4. 编辑镜像

仪表板允许您编辑镜像

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

流程

- 登录到仪表板。

在导航栏中,点 Block :

从下拉菜单中选择 Images :

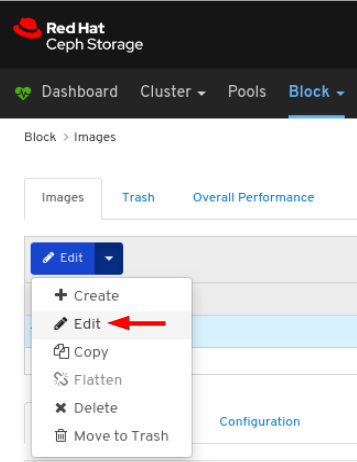

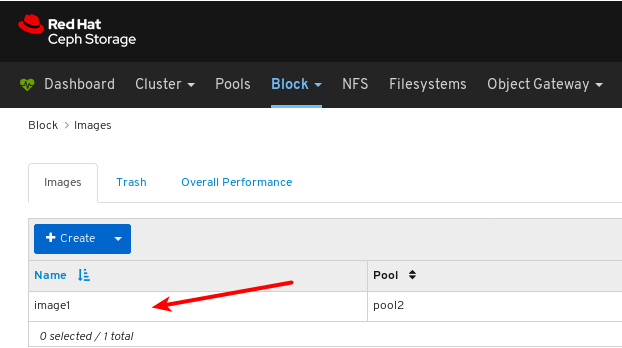

要编辑镜像,在 Images 选项卡中点其行:

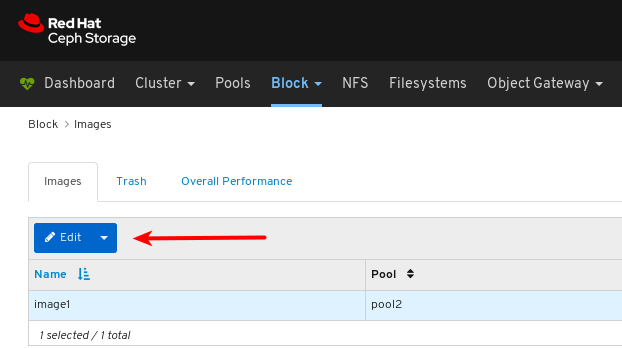

在 Edit 下拉菜单中选择 Edit:

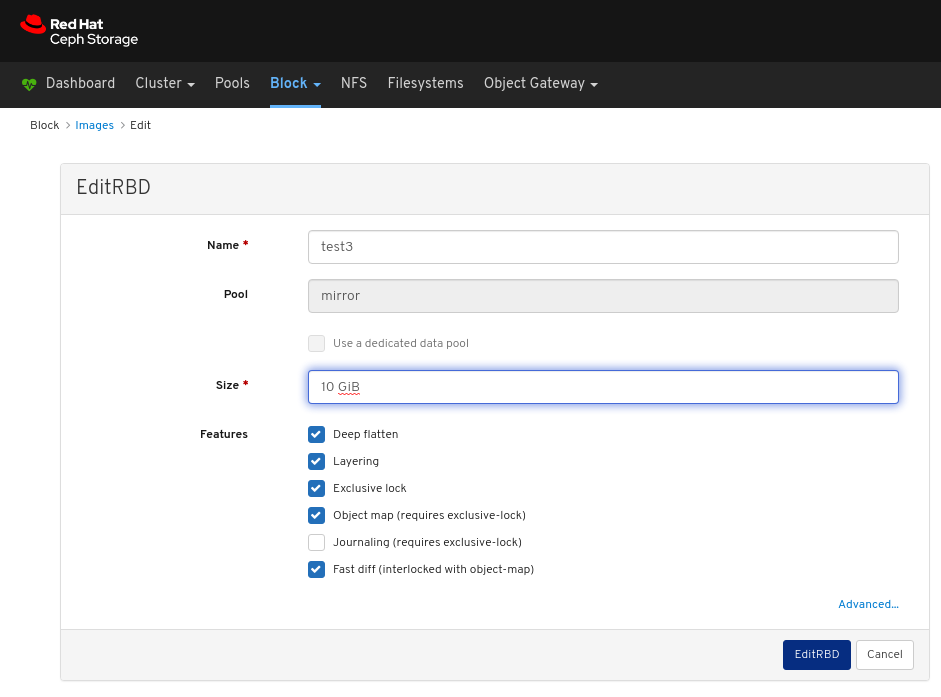

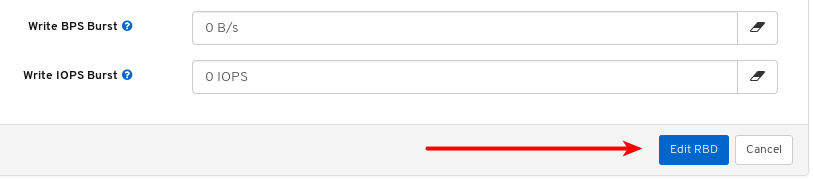

在 EditRBD 对话框中,编辑所需的参数并点 EditRBD 按钮:

对页面右上角的通知表示镜像已被成功更新。

其它资源

- 如需更多信息,请参阅 Red Hat Ceph Storage Dashboard 指南中的 创建镜像 部分。

9.2.5. 复制镜像

仪表板允许您复制镜像。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

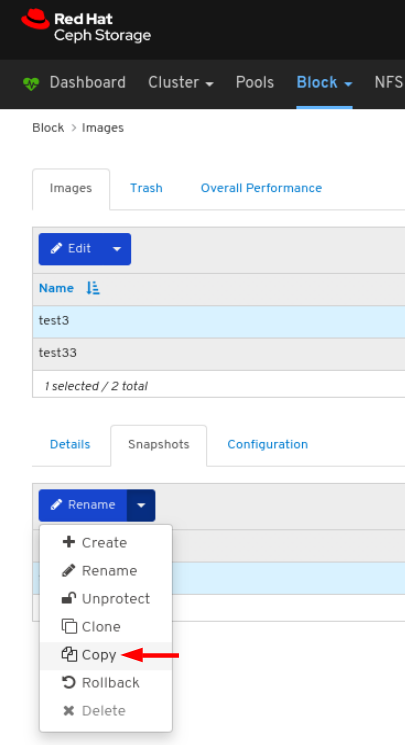

流程

- 登录到仪表板。

在导航栏中,点 Block :

从下拉菜单中选择 Images :

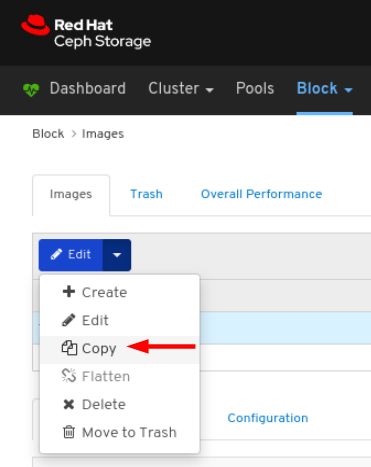

要复制镜像,在 Images 选项卡中点其行:

选择 Copy in the Edit 下拉列表:

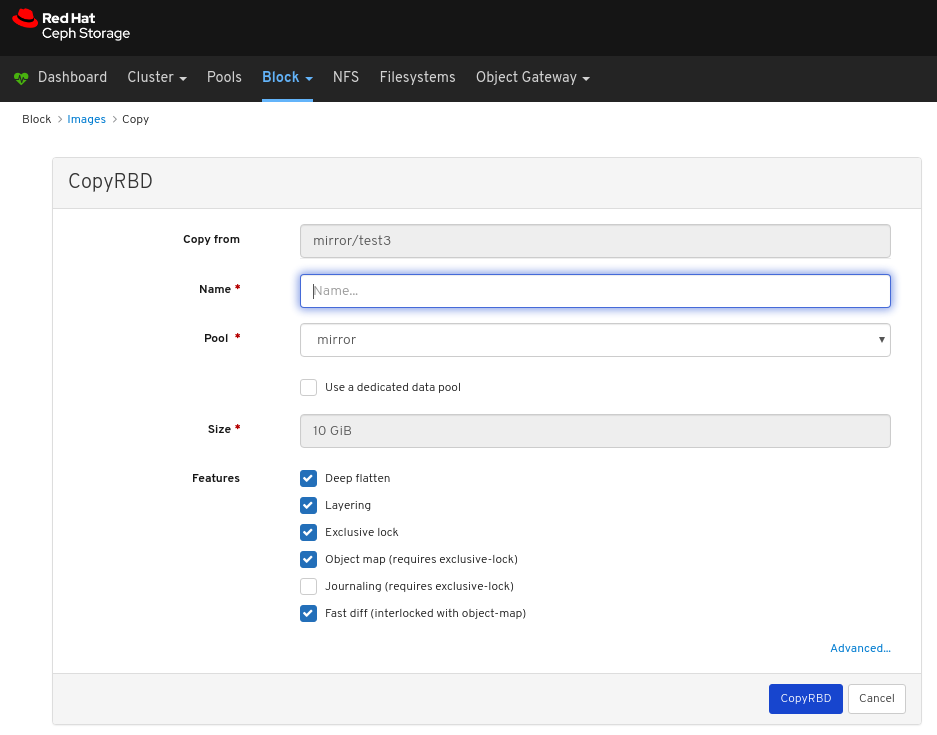

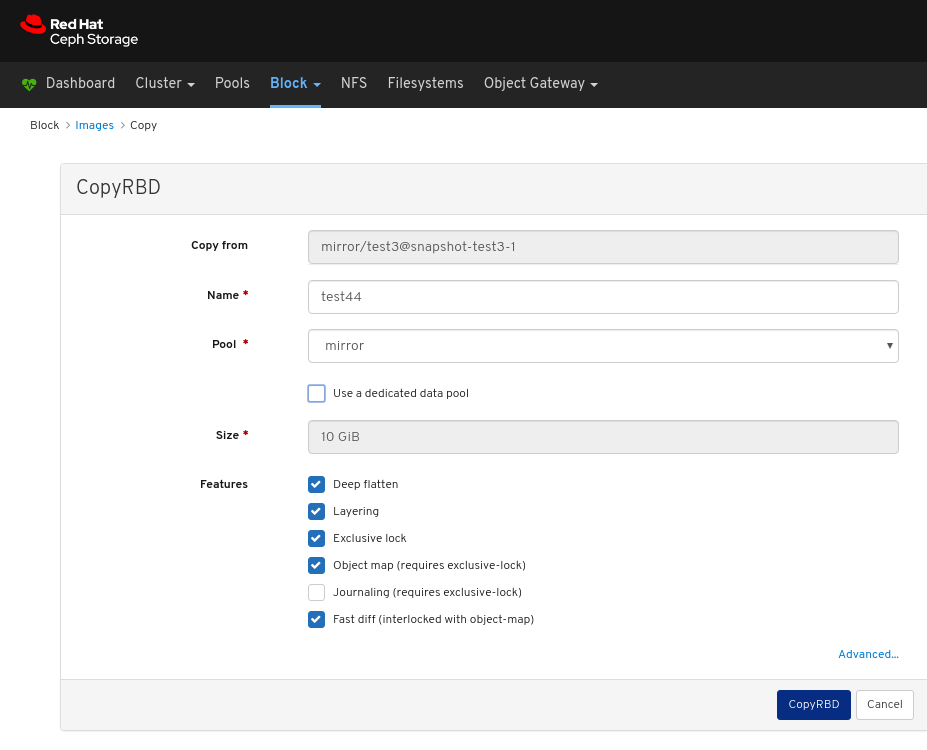

在 CopyRBD 窗口中,编辑所需的参数,然后单击 CopyRBD 按钮:

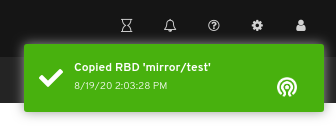

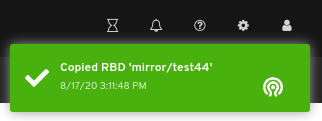

对页面右上角的通知表示镜像已被成功更新。

其它资源

- 如需更多信息,请参阅 Red Hat Ceph Storage Dashboard 指南中的 创建镜像 部分。

9.2.6. 将镜像移动到回收站

通过控制面板,您可以将镜像移动到回收站。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

流程

- 登录到仪表板。

在导航栏中,点 Block :

从下拉菜单中选择 Images :

要将镜像移动到 Trash,在 Images 选项卡中点其行:

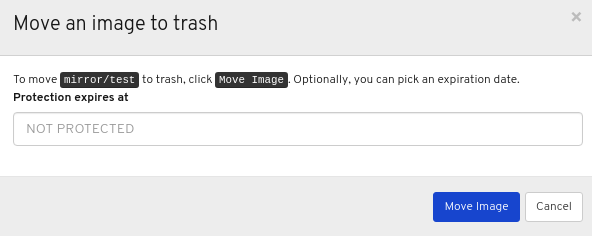

选择 Move to Trash in the Edit 下拉菜单:

在 Moving a image to trash 窗口中,编辑镜像需要保护的日期,然后单击 Move Image 按钮:

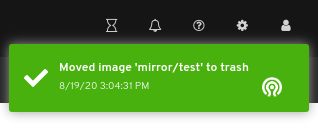

该页面右上角发出的通知表示镜像已成功移到垃圾箱中。

9.2.7. purging trash

仪表板允许您清除镜像的垃圾箱。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已回收镜像。

流程

- 登录到仪表板。

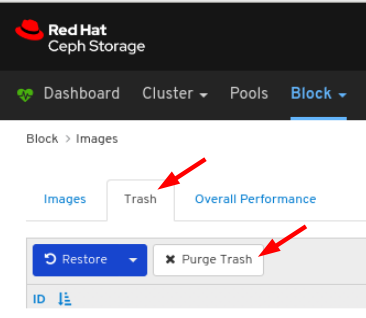

在导航栏中,点 Block :

从下拉菜单中选择 Images :

在 Trash 选项卡中,点 Purge Trash 按钮:

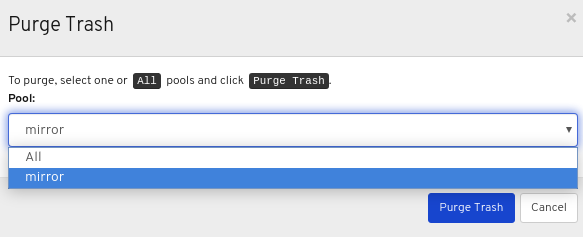

在 Purge Trash 窗口中,选择池,然后单击 清除垃圾 按钮:

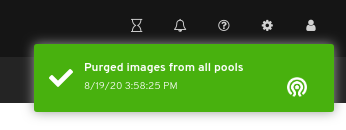

对页面右上角的通知表示已成功从所选池中清除镜像。

其它资源

- 如需了解更多详细信息,请参阅 Red Hat Ceph Storage Block Device Guide 中的 Purging the Block Device 一节。

9.2.8. 从回收站中恢复镜像

仪表板允许您从回收站中恢复镜像。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已回收镜像。

流程

- 登录到仪表板。

在导航栏中,点 Block :

从下拉菜单中选择 Images :

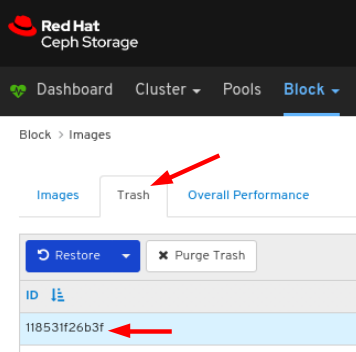

要从 Trash 选项卡中恢复镜像,请点击它的行:

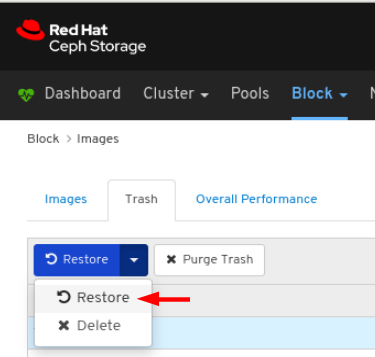

在 Restore 下拉列表中选择 Restore:

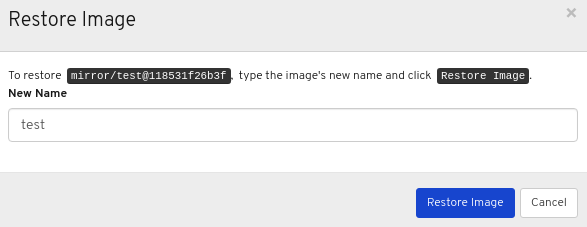

在 Restore Image 窗口中,输入镜像的名称,然后点 Restore Image 按钮:

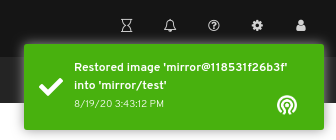

页面右上角发出的通知表示镜像已从回收站中恢复。

其它资源

- 有关在 RBD 池中创建镜像 的更多信息,请参阅 Red Hat Ceph Storage Dashboard Guide 中的创建镜像部分。

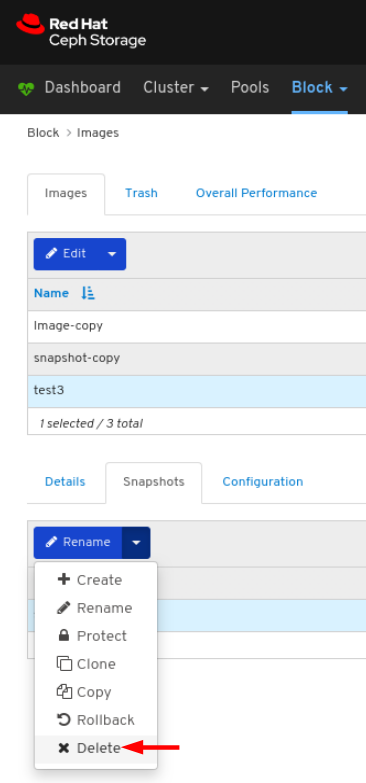

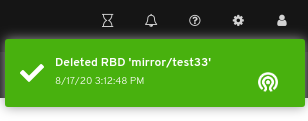

9.2.9. 删除镜像

仪表板允许您删除镜像。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

流程

- 登录到仪表板。

在导航栏中,点 Block :

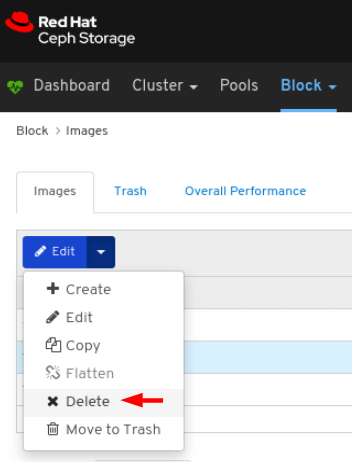

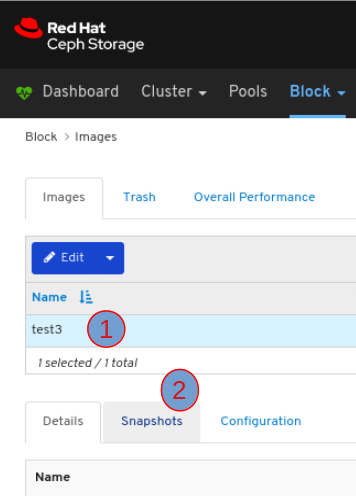

从下拉菜单中选择 Images :

要编辑镜像,在 Images 选项卡中点其行:

在 Edit 下拉菜单中选择 Delete:

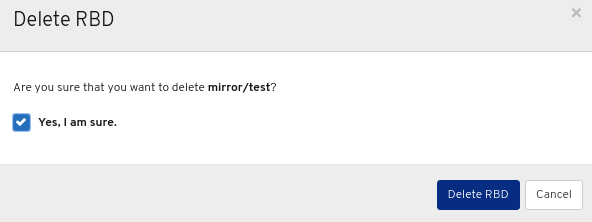

在 Delete RBD 对话框窗口中 ,单击 Yes,再单击 Delete RBD 以保存设置:

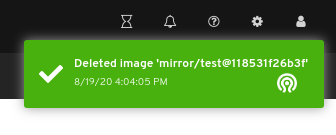

该页面右上角发出的通知表示镜像已成功移到垃圾箱中。

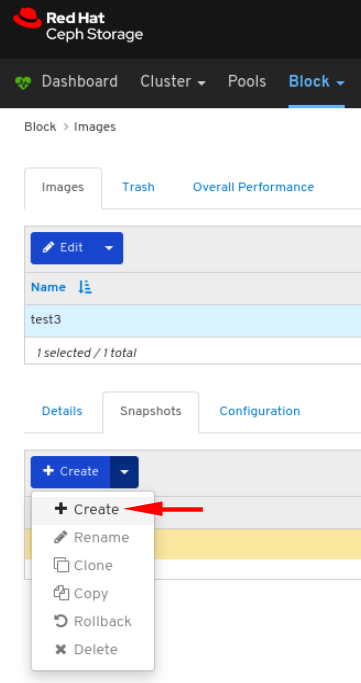

9.2.10. 创建镜像快照

通过控制面板,您可以拍摄 Ceph 块设备镜像的快照。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

流程

- 登录到仪表板。

在导航栏中,点 Block :

从下拉菜单中选择 Images :

要生成镜像的快照,在 Images 选项卡中点其行,然后点 Snapshots 选项卡:

在 Create 下拉列表中选择 Create:

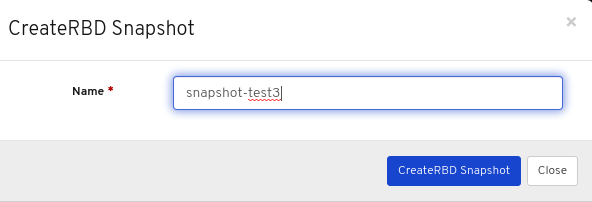

在 CreateRBD Snapshot 对话框中,输入参数,再单击 CreateRBD Snapshot 按钮:

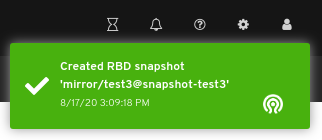

页面右上角发出的通知表示已成功创建映像的快照。

其它资源

- 有关 创建快照的更多信息,请参阅 Red Hat Ceph Storage Block Device Guide] 中创建块设备 快照部分。

- 如需了解更多与创建 RBD 池的详细信息,请参阅 Red Hat Ceph Storage Dashboard Guide 中的创建池部分。

- 如需了解更多详细信息,请参阅 Red Hat Ceph Storage Dashboard Guide 中的创建镜像部分。 https://access.redhat.com/documentation/en-us/red_hat_ceph_storage/4/html-single/dashboard_guide/#creating-images_dash

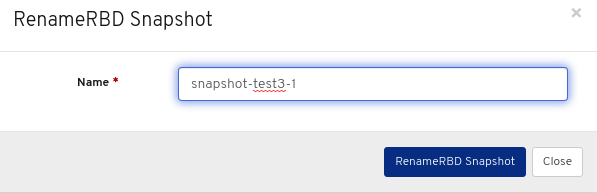

9.2.11. 重命名镜像快照

控制面板允许您重命名 Ceph 块设备镜像的快照。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

- 创建镜像的快照。

流程

- 登录到仪表板。

在导航栏中,点 Block :

从下拉菜单中选择 Images :

要重命名镜像的快照,在 Images 选项卡中点其行,然后点 Snapshots 选项卡:

在 Rename 下拉菜单中选择 Rename:

在 RenameRBD Snapshot 对话框中,输入参数并点 RenameRBD Snapshot 按钮:

对页面右上角的通知表示已成功更新镜像的快照。

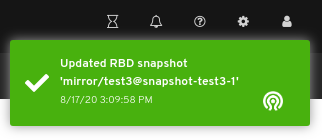

9.2.12. 保护镜像快照

控制面板允许您保护 Ceph 块设备镜像的快照。当您需要克隆快照时,这是必需的。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

- 创建镜像的快照。

流程

- 登录到仪表板。

在导航栏中,点 Block :

从下拉菜单中选择 Images :

要保护镜像的快照,在 Images 选项卡中点其行,然后点 Snapshots 选项卡:

在 Rename 下拉菜单中选择 Protect:

对页面右上角的通知表示已成功更新镜像的快照。

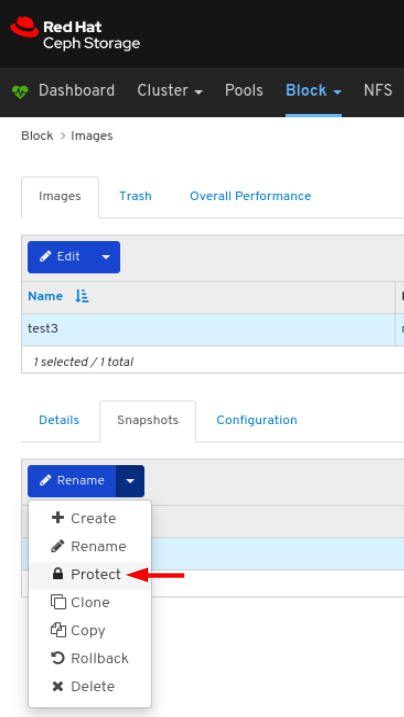

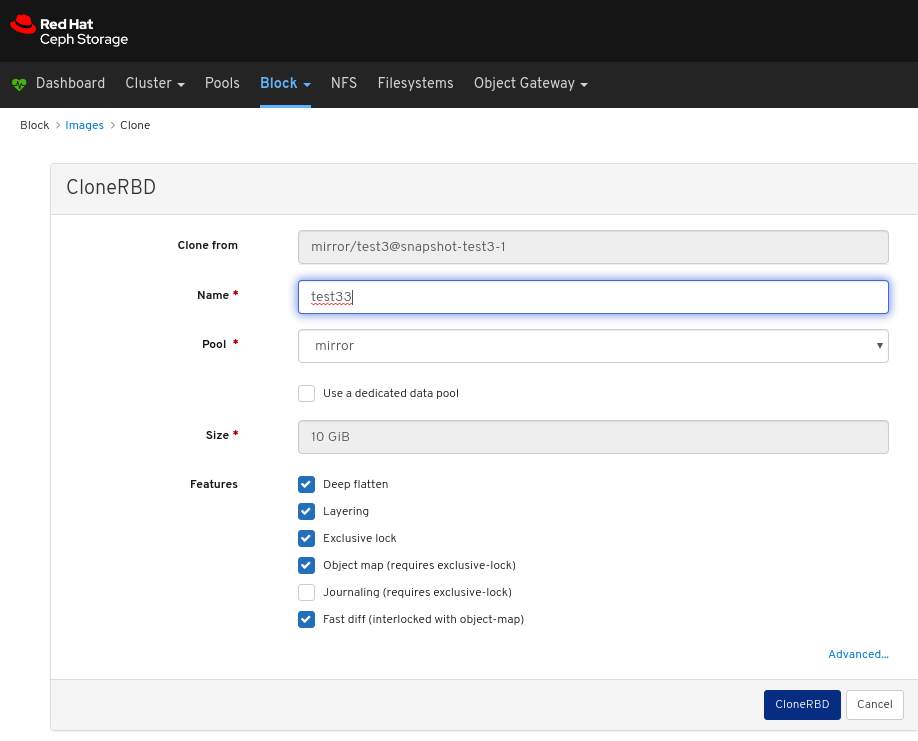

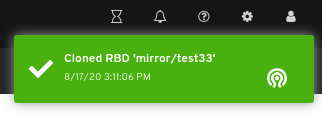

9.2.13. 克隆镜像快照

通过控制面板,您可以克隆 Ceph 块设备镜像的快照。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

- 创建镜像的快照。

- 镜像的快照受到保护。

流程

- 登录到仪表板。

在导航栏中,点 Block :

从下拉菜单中选择 Images :

要克隆镜像的快照,在 Images 选项卡中点其行,然后点 Snapshots 选项卡:

在 Rename 下拉菜单中选择 Clone :

在 CloneRBD 对话框中,输入参数并点 CloneRBD 按钮:

页面右上角发出的通知表示已成功克隆镜像的快照。

其它资源

- 如需更多信息,请参阅 Red Hat Ceph Storage Block Device Guide] 中的重新定义 块设备快照 部分。

- 如需更多信息,请参阅 Red Hat Ceph Storage Block Device Guide中的保护块设备快照 部分。

- 如需了解更多与创建 RBD 池的详细信息,请参阅 Red Hat Ceph Storage Dashboard Guide 中的创建池部分。

- 有关在 RBD 池中创建镜像 的更多信息,请参阅 Red Hat Ceph Storage Dashboard Guide 中的创建镜像部分。

- 如需了解更多详细信息,请参阅 Red Hat Ceph Storage Dashboard 指南中的 保护镜像快照部分。

9.2.14. 复制镜像快照

通过控制面板,您可以复制 Ceph 块设备镜像的快照。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

- 创建镜像的快照。

流程

- 登录到仪表板。

在导航栏中,点 Block :

从下拉菜单中选择 Images :

要复制镜像的快照,在 Images 选项卡中点其行,然后点 Snapshots 选项卡:

在 Rename 下拉菜单中选择 Copy :

在 CopyRBD 对话框中,输入参数并单击 CopyRBD 按钮:

对页面右上角的通知表示已成功更新镜像的快照。

9.2.15. 镜像的回滚快照

通过控制面板,您可以回滚 Ceph 块设备镜像的快照。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

- 创建镜像的快照。

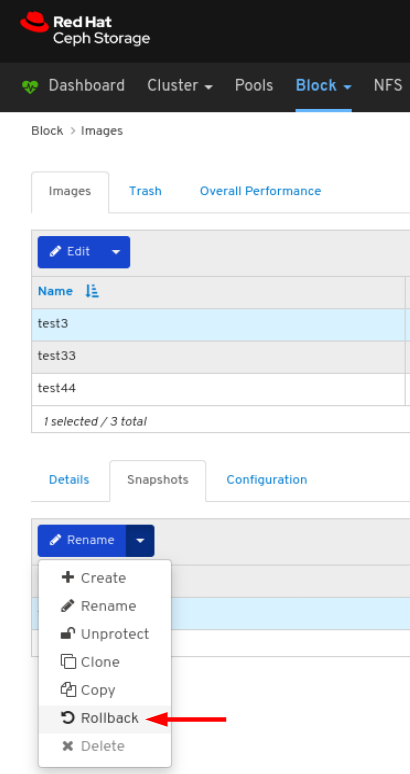

流程

- 登录到仪表板。

在导航栏中,点 Block :

从下拉菜单中选择 Images :

要回滚镜像的快照,在 Images 选项卡中点其行,然后点 Snapshots 选项卡:

在 Rename 下拉菜单中选择 Rollback:

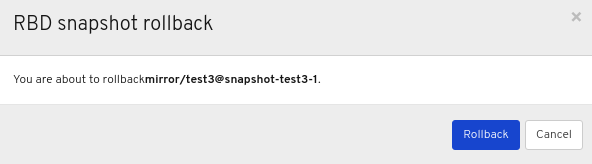

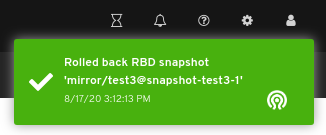

在 RBD 快照回滚 窗口中,单击 Rollback 按钮:

对页面右上角的通知表示已成功回滚镜像的快照。

其它资源

- 如需更多信息,请参阅 Red Hat Ceph Storage Block Device Guide] 中的 Rolling a 块设备快照 部分。

- 如需了解更多详细信息,请参阅 Red Hat Ceph Storage Dashboard Guide 中的创建池部分。 https://access.redhat.com/documentation/en-us/red_hat_ceph_storage/4/html-single/dashboard_guide/#creating-pools_dash

- 如需了解更多详细信息,请参阅 Red Hat Ceph Storage Dashboard Guide 中的创建镜像部分。 https://access.redhat.com/documentation/en-us/red_hat_ceph_storage/4/html-single/dashboard_guide/#creating-images_dash

9.2.16. 取消保护镜像快照

通过控制面板,您可以取消保护 Ceph 块设备镜像的快照。当您需要删除快照时,这是必需的。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

- 创建镜像的快照。

- 镜像的快照受到保护。

流程

- 登录到仪表板。

在导航栏中,点 Block :

从下拉菜单中选择 Images :

要取消保护镜像的快照,在 Images 选项卡中点其行,然后点 Snapshots 选项卡:

在 Rename 下拉菜单中选择 UnProtect:

对页面右上角的通知表示已成功更新镜像的快照。

9.2.17. 删除镜像快照

通过控制面板,您可以删除 Ceph 块设备镜像的快照。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

- 创建镜像的快照。

- 镜像的快照未受保护。

流程

- 登录到仪表板。

在导航栏中,点 Block :

从下拉菜单中选择 Images :

要删除镜像的快照,在 Images 选项卡中点其行,然后点 Snapshots 选项卡:

在 Rename 下拉菜单中选择 Delete :

对页面右上角的通知表示已成功更新镜像的快照。

9.3. 镜像功能

通过控制面板,您可以管理和监控镜像功能。

9.3.1. 先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

9.3.2. 镜像视图

通过控制面板,您可以查看镜像功能的整体状态。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 镜像功能已配置。

流程

- 登录到仪表板。

- 在导航栏中,单击 Block。

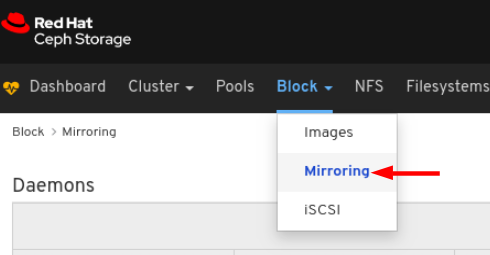

点击 镜像功能 :

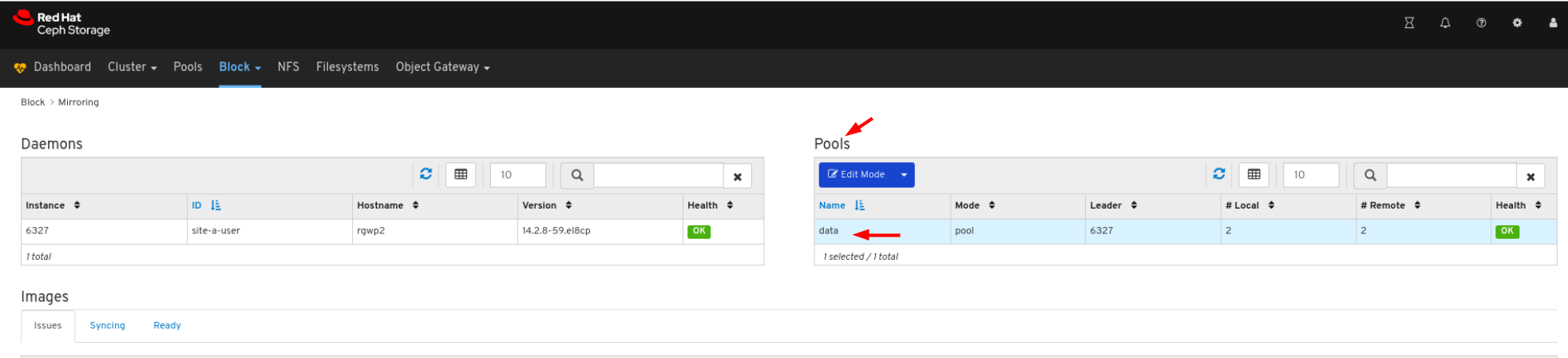

在上例中,您可以看到镜像信息归类到标有 Daemons、Pools 和 Images 的表中。

9.3.3. 编辑模式

通过控制面板,您可以编辑镜像功能(包括池和镜像)的整体状态模式。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

- 镜像功能已配置。

流程

- 登录到仪表板。

在导航栏中,点 Block :

从下拉菜单中 点 image:

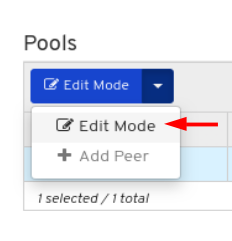

在 池选项卡 中点行:

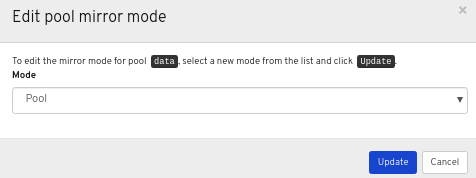

在 Edit Mode 下拉菜单中选择 Edit Mode:

在 Edit Pool mirror mode 窗口中,从下拉菜单中选择模式,然后点 Update 按钮:

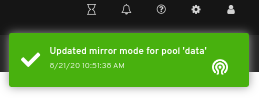

对页面右上角的通知表示已成功更新镜像模式。

其它资源

- 如需更多信息,请参阅 Red Hat Ceph Storage Block Device Guide中的 Ceph Block Device 镜像 部分。

9.3.4. 在镜像中添加 peer

仪表板允许您为'rbd-daemon' 镜像添加存储集群 peer 来发现其对等存储集群。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

- 镜像功能已配置。

流程

- 登录到仪表板。

在导航栏中,点 Block :

从下拉菜单中 点 image:

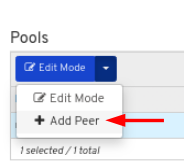

在 池选项卡 中点行

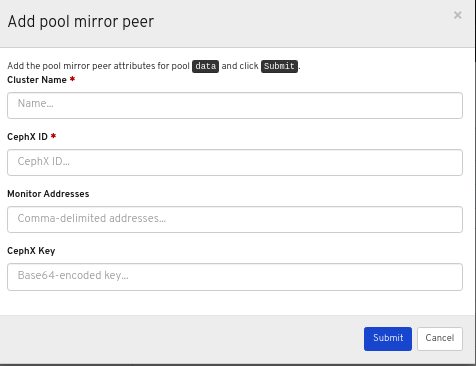

在 Edit Mode 下拉菜单中,选择 Add peer :

在 Add pool mirror peer 窗口中,输入参数,然后点 Submit 按钮:

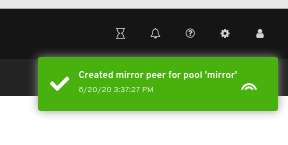

对页面右上角的通知表示镜像对等点已成功创建。

其它资源

- 如需更多信息,请参阅 Red Hat Ceph Storage Block Device Guide 中的 Adding a storage cluster peer 部分。

9.3.5. 编辑镜像中的 peer

仪表板允许您编辑 'rbd-daemon' mirror 的存储集群来发现其对等存储集群。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

- 镜像功能已配置。

- 添加了对等点。

流程

- 登录到仪表板。

在导航栏中,单击 Block。

从下拉菜单中 点 image:

在 池选项卡 中点行

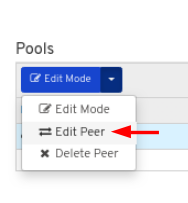

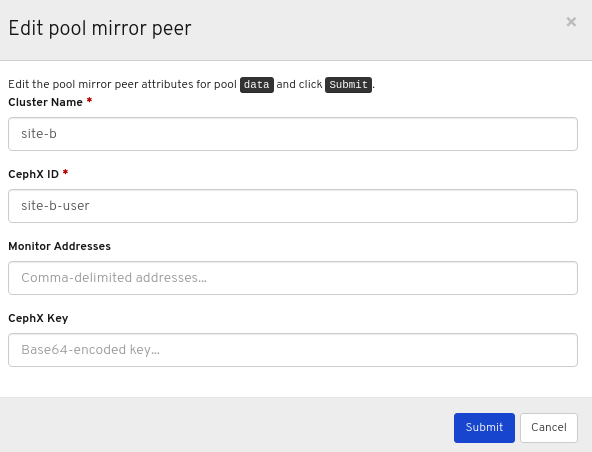

在 Edit Mode 下拉菜单中选择 Edit peer:

在 Edit pool mirror peer 窗口中,编辑参数,然后点 Submit 按钮:

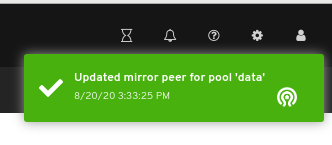

对页面右上角的通知表示镜像对等点已被成功更新。

其它资源

- 如需更多信息,请参阅 Red Hat Ceph Storage Dashboard 指南中的镜像部分添加 peer 部分。

9.3.6. 删除镜像中的 peer

仪表板允许您编辑 'rbd-daemon' mirror 的存储集群来发现其对等存储集群。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

- 镜像功能已配置。

- 添加了对等点。

流程

- 登录到仪表板。

在导航栏中,单击 Block。

从下拉菜单中 点 image:

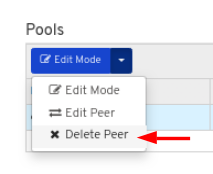

在 池选项卡 中点行:

在 Edit Mode 下拉菜单中,选择 Delete peer :

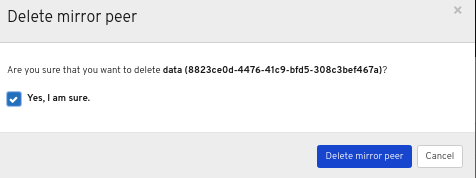

在 Delete mirror peer 对话框窗口中,点 Yes, I am sure box,然后单击 Delete mirror peer 以保存设置:

该页面右上角发出的通知表示镜像已成功移到垃圾箱中。

其它资源

- 如需更多信息,请参阅 Red Hat Ceph Storage Dashboard 指南中的镜像部分添加 peer 部分。

9.4. iSCSI 功能(有限的可用性)

控制面板允许您管理和监控 iSCSI 镜像和目标。在使用控制面板管理和监控 iSCSI 镜像和目标之前,您必须在其中添加网关并启用仪表板 iSCSI 功能。

该技术是有限可用性。如需更多信息,请参阅 已弃用的功能 章节。

9.4.1. 先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- iSCSI 网关 添加到仪表板 中。

9.4.2. 在仪表板中手动添加 iSCSI 网关

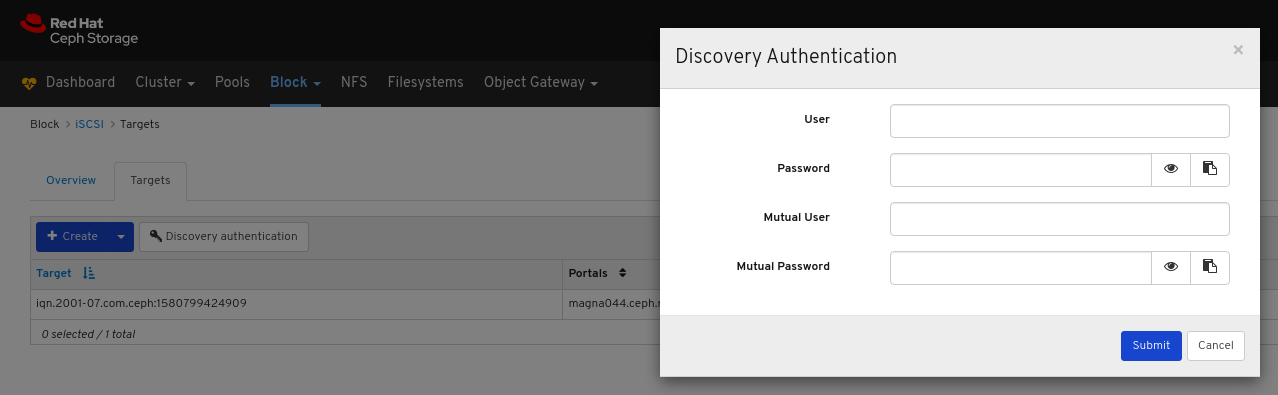

Red Hat Ceph Storage Dashboard 可以使用 Ceph iSCSI 网关的 rbd-target-api 服务提供的 REST API 管理 iSCSI 目标。您必须在仪表板中添加 API 地址,然后才能访问它。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph iSCSI 网关。

Ceph iSCSI 网关需要最低两个网关,才能提供高可用性。

流程

- 登录 monitor 节点。

可选:如果使用自签名证书在 HTTPS 模式中配置 iSCSI 网关的 REST API,您必须配置仪表板以避免访问 API 时的 SSL 证书验证。运行以下命令以禁用 SSL 验证。

ceph dashboard set-iscsi-api-ssl-verification false

# ceph dashboard set-iscsi-api-ssl-verification falseCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

ceph dashboard set-iscsi-api-ssl-verification false

[root@mon ~]# ceph dashboard set-iscsi-api-ssl-verification false Option ISCSI_API_SSL_VERIFICATION updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 为网关创建两个文件:

echo "SCHEME :// USERNAME : PASSWORD @ HOST [: PORT ]" > FILE_CONTAINING_GATEWAY_URL

# echo "SCHEME :// USERNAME : PASSWORD @ HOST [: PORT ]" > FILE_CONTAINING_GATEWAY_URLCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

echo "http://admin:admin@192.168.122.157:5000" > /tmp/first_gateway echo "http://admin:admin@192.168.122.193:5000" > /tmp/second_gateway

[root@mon ~]# echo "http://admin:admin@192.168.122.157:5000" > /tmp/first_gateway [root@mon ~]# echo "http://admin:admin@192.168.122.193:5000" > /tmp/second_gatewayCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意配置 iSCSI 目标 时设置了 USERNAME 和 PASSWORD。其凭据可以从 iSCSI 网关节点上的

iscsi-gateway.cfg文件中检索。在仪表板中添加两个网关:

ceph dashboard iscsi-gateway-add -i FILE_CONTAINING_GATEWAY_URL

# ceph dashboard iscsi-gateway-add -i FILE_CONTAINING_GATEWAY_URLCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

ceph dashboard iscsi-gateway-add -i /tmp/first_gateway ceph dashboard iscsi-gateway-add -i /tmp/second_gateway

[root@mon ~]# ceph dashboard iscsi-gateway-add -i /tmp/first_gateway Success [root@mon ~]# ceph dashboard iscsi-gateway-add -i /tmp/second_gateway SuccessCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证网关是否已正确添加:

ceph dashboard iscsi-gateway-list

# ceph dashboard iscsi-gateway-listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

ceph dashboard iscsi-gateway-list

[root@mon ~]# ceph dashboard iscsi-gateway-list {"gateways": {"ceph4": {"service_url": "http://admin:admin@192.168.122.193:5000"}, "ceph4": {"service_url": "http://admin:admin@192.168.122.193:5000"}}}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:如果添加网关时出错,您可以通过在

iscsi-gateway-list中指定其主机名来删除它:ceph dashboard iscsi-gateway-rm GATEWAY_NAME

# ceph dashboard iscsi-gateway-rm GATEWAY_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

ceph dashboard iscsi-gateway-rm ceph4

[root@mon ~]# ceph dashboard iscsi-gateway-rm ceph4 SuccessCopy to Clipboard Copied! Toggle word wrap Toggle overflow

其它资源

- 有关如何安装 Ceph iSCSI 网关的详情,请参考 《块设备指南》 中的 安装 iSCSI 网关。

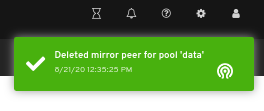

9.4.3. iSCSI 概述

控制面板提供概述,其中显示了通过 iSCSI 导出的 iSCSI 网关主机和镜像。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph iSCSI 网关。

- iSCSI 网关添加到仪表板中。

- 启用仪表板 iSCSI 功能。

流程

- 登录到仪表板。

- 在导航栏中,单击 Block。

点击 iSCSI :

其它资源

- 有关如何安装 Ceph iSCSI 网关的详情,请参考 《块设备指南》 中的 安装 iSCSI 网关。

- 有关如何在控制面板中添加 iSCSI 网关的详情,请参考控制面板中 手动将 iSCSI 网关添加到仪表板中。https://access.redhat.com/documentation/en-us/red_hat_ceph_storage/4/html-single/dashboard_guide/

- 有关如何启用控制面板 iSCSI 功能的详情 ,请参考 控制面板指南中的 启用仪表板 iSCSI 功能。

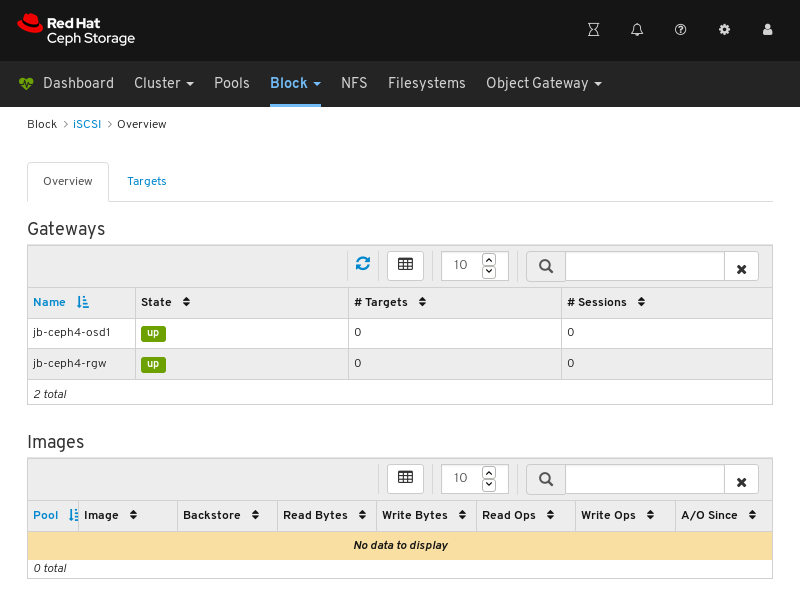

9.4.4. 创建 iSCSI 目标

仪表板允许您创建 iSCSI 目标。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- Ceph iSCSI 网关安装至少有两个网关。

- iSCSI 网关添加到仪表板中。

- 启用仪表板 iSCSI 功能。

- 启用了 RBD 应用的复制池。

- 启用了 RBD 应用的纠删代码池。

流程

- 登录到仪表板。

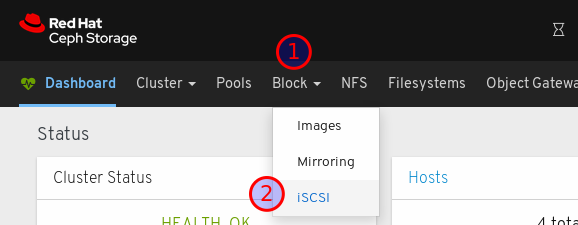

- 在导航栏中,单击 Block。

点击 iSCSI :

在页面的左上角点击 Targets 选项卡:

在页面的左上角点击 Add 按钮:

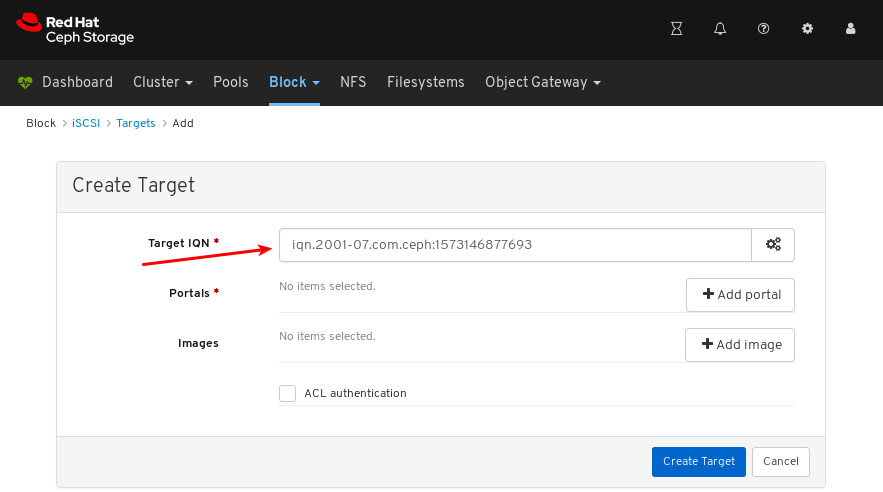

可选:修改目标 IQN。

可选:为目标设置高级设置。

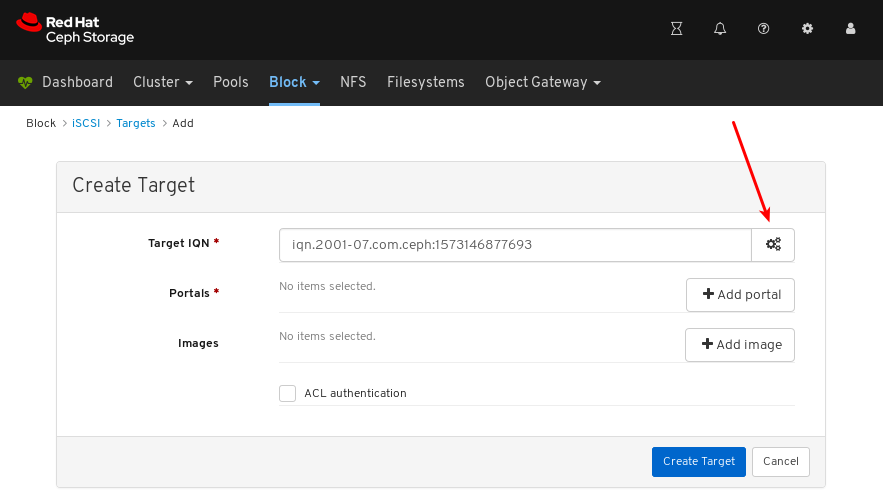

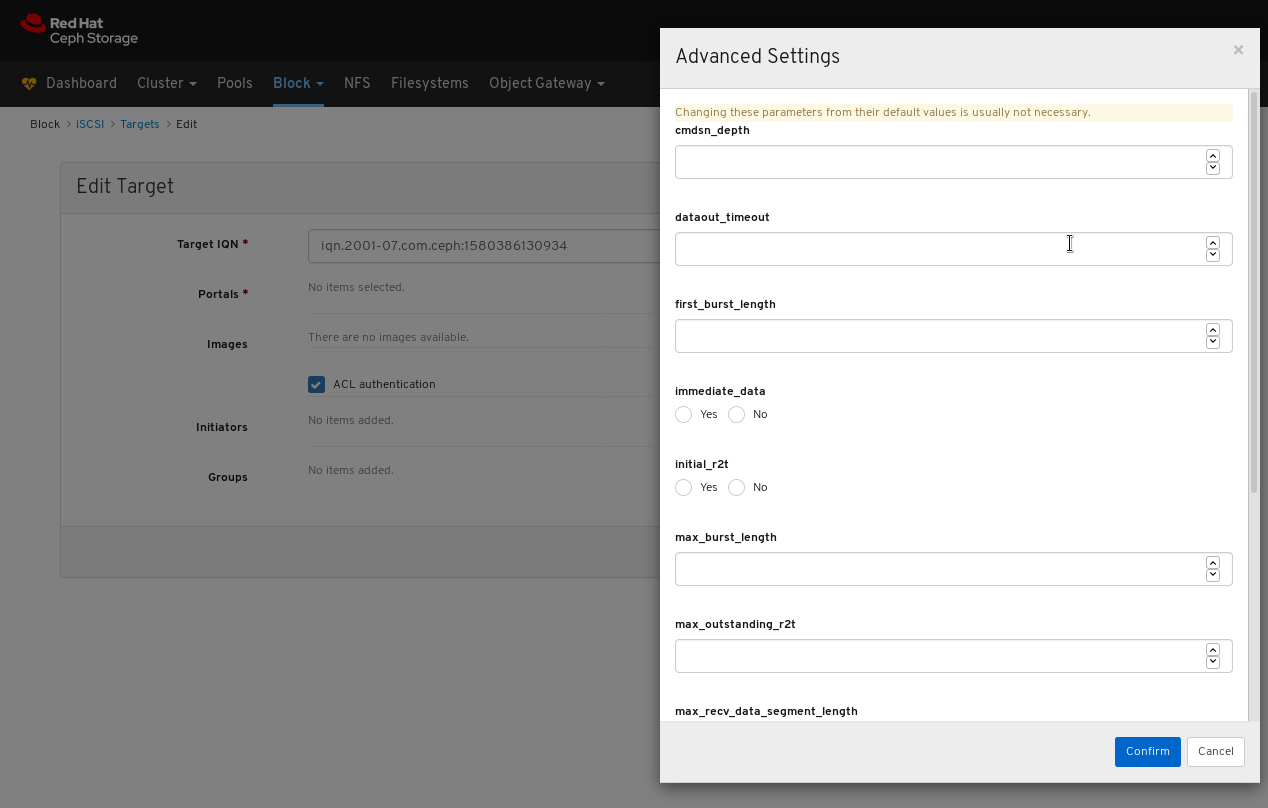

点击 gear 为目标设置高级设置。

在 Advanced Settings 对话框窗口中设置高级设置。

- 点 Confirm 保存设置。

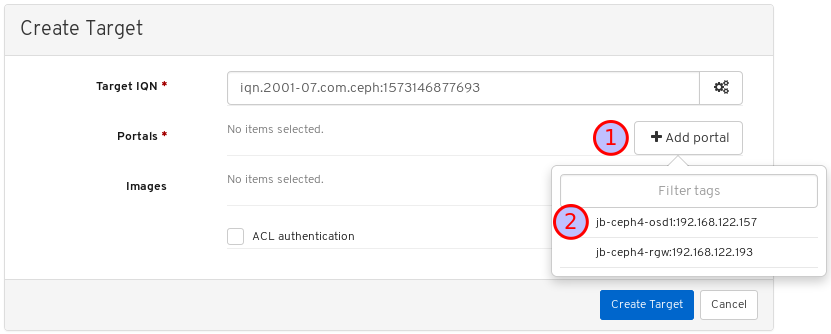

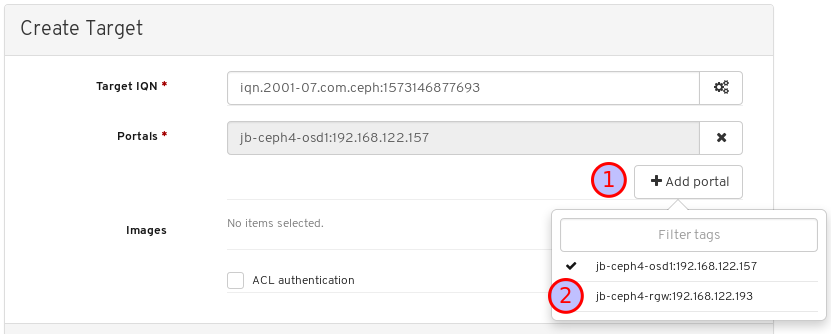

点 Add portal 按钮并选择至少两个网关中的第一个:

点 Add portal 按钮并选择至少两个网关的第二个网关:

为任何其他网关重复此步骤。

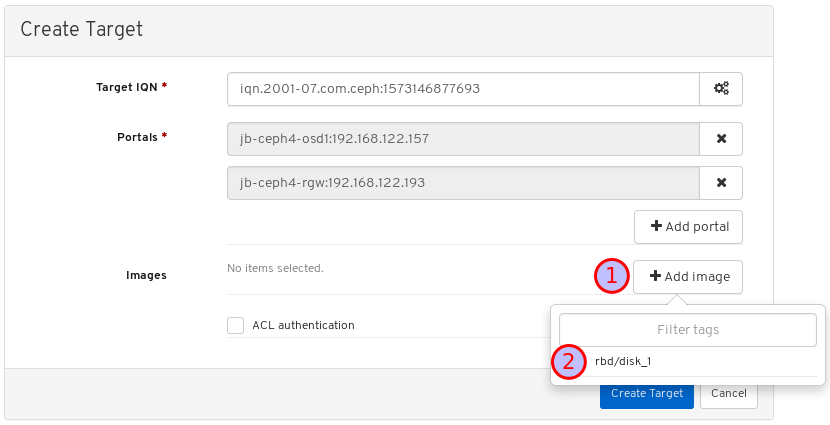

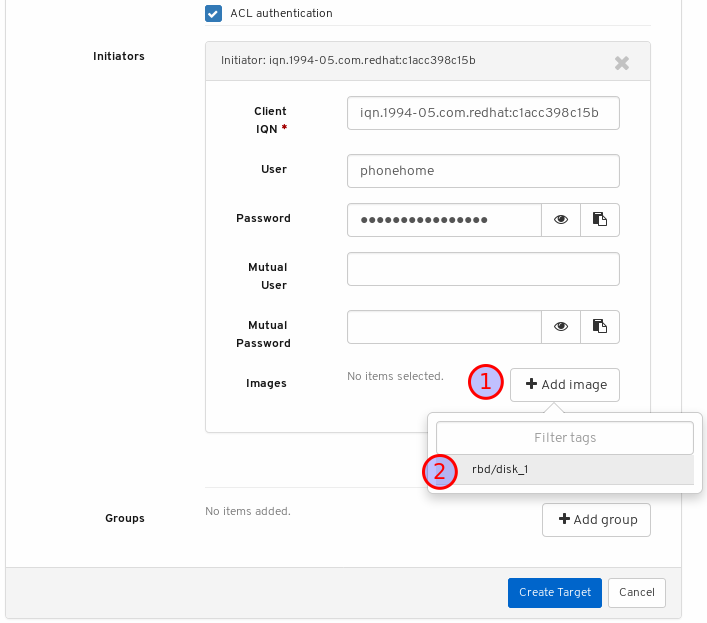

点 Add image 按钮并选择目标要导出的镜像:

为任何其他镜像重复此步骤。

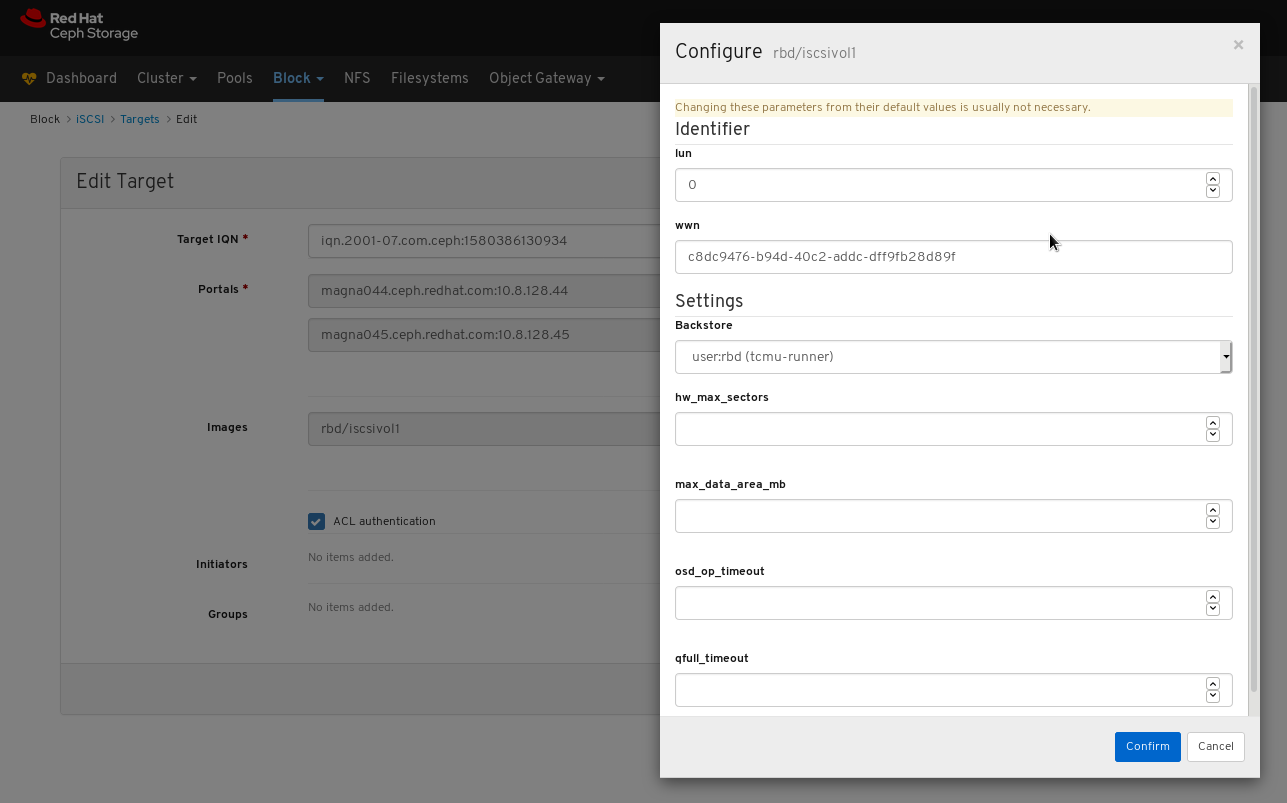

可选:修改镜像。

点击镜像右侧的 gear

在配置对话框窗口中修改镜像设置:

- 点 Confirm 保存设置。

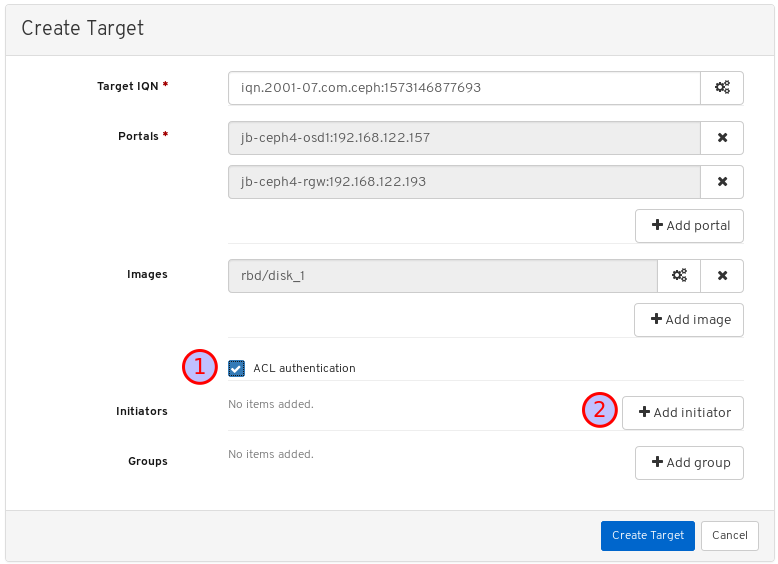

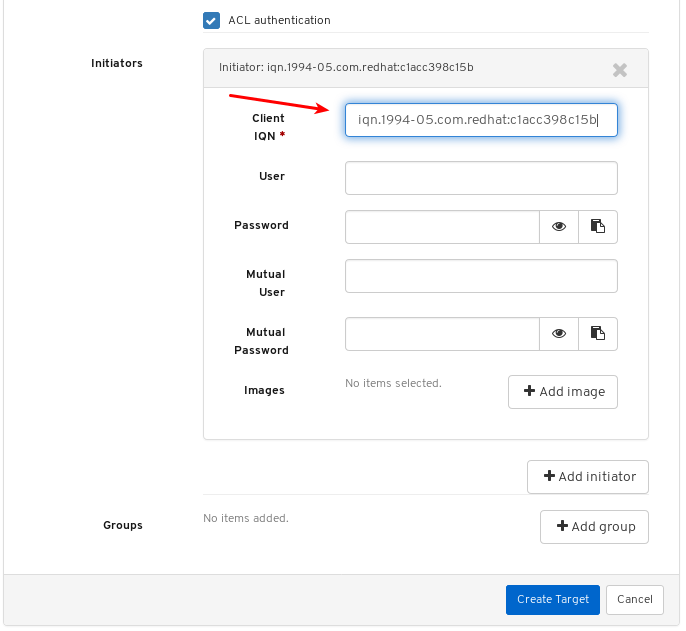

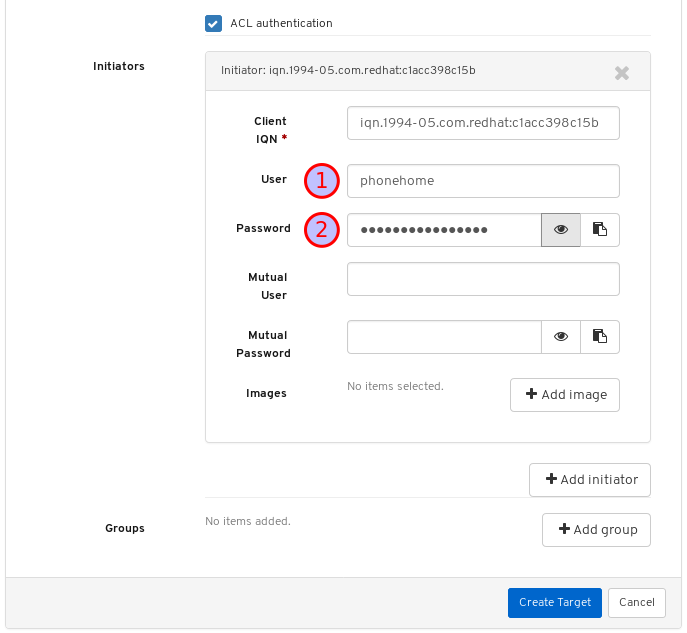

点击 ACL 身份验证 框,然后点 添加发起程序 按钮:

在第一个文本框中从客户端输入 IQN:

从 initiator 软件运行的系统中检索客户端 IQN。如需更多信息 ,请参阅 块设备指南中的 配置 iSCSI 启动器。

输入目标的用户名和密码详情:

点 Add image 并选择镜像:

为任何其他镜像重复此步骤。

点击 Create Target 按钮完成此步骤:

通过在 Targets 页面中查找目标来验证已添加目标。

要找到 Targets 页面,请按照 控制面板指南中的 查看 iSCSI 目标 的步骤。

其它资源

- 有关如何安装 Ceph iSCSI 网关的详情,请参考 《块设备指南》 中的 安装 iSCSI 网关。

- 有关如何在控制面板中添加 iSCSI 网关的详情,请参考控制面板中 手动将 iSCSI 网关添加到仪表板中。https://access.redhat.com/documentation/en-us/red_hat_ceph_storage/4/html-single/dashboard_guide/

- 有关如何启用控制面板 iSCSI 功能的详情 ,请参考 控制面板指南中的 启用仪表板 iSCSI 功能。

- 有关如何创建启用了 RBD 应用的池的信息,请参阅《 块设备 指南》中的创建块设备 池

- 有关如何创建镜像的详情,请参考在块设备 指南中创建块设备镜像。

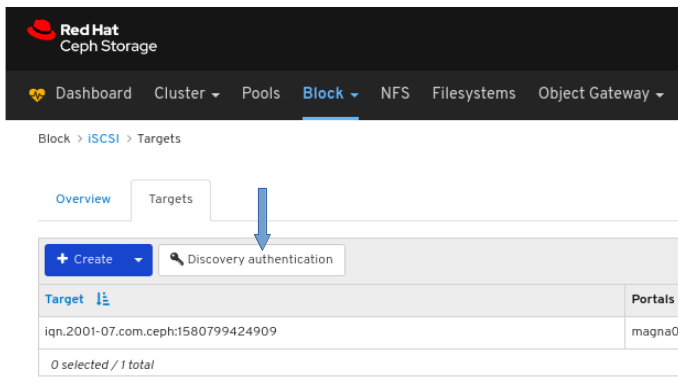

9.4.5. 查看 iSCSI 目标

仪表板允许您查看 iSCSI 目标。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- 已安装 Ceph iSCSI 网关。

- 已创建一个 iSCSI 目标。

流程

- 登录到仪表板。

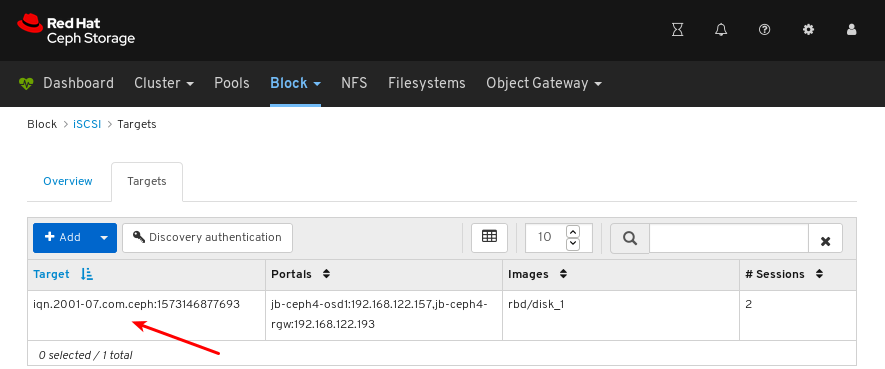

在导航栏中,单击 Block,然后单击 iSCSI :

在页面的左上角点击 Targets 选项卡:

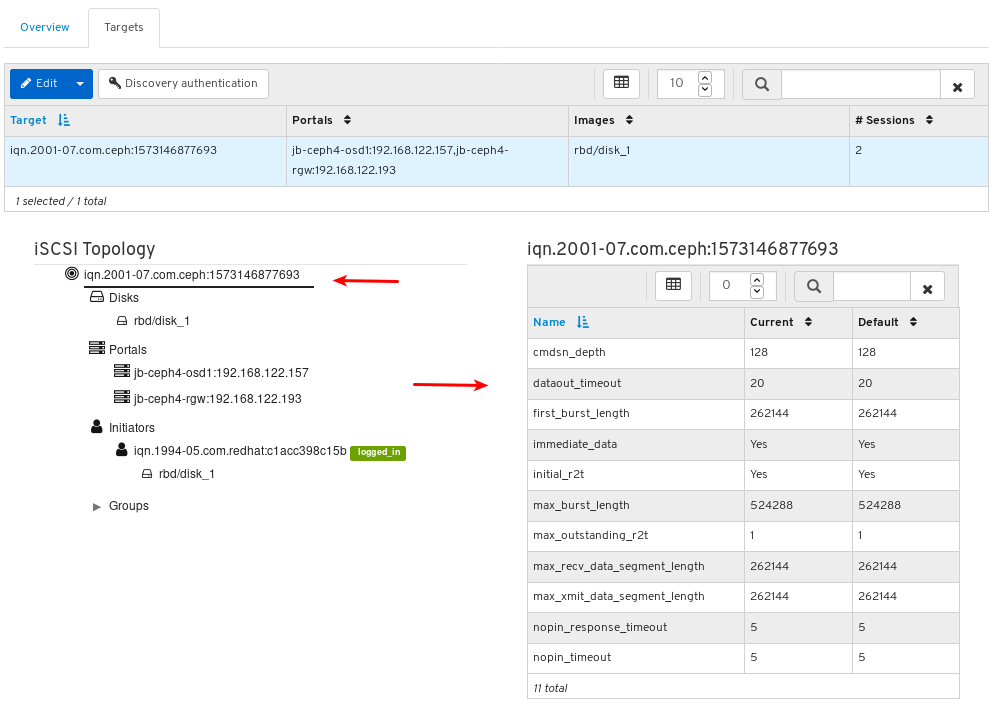

要查看目标的详情,请点击它的行:

您可以查看 iSCSI 拓扑,包括发起方是否登录:

点击对象来查看它的详细信息:

注意:只有有些对象才会在点击时显示详细信息。

其它资源

- 有关如何安装 Ceph iSCSI 网关的详情,请参考 《块设备指南》 中的 安装 iSCSI 网关。

- 有关如何在仪表板中创建 iSCSI 目标的详情,请参考 控制面板指南中的 创建 iSCSI 目标。

9.4.6. 编辑 iSCSI 目标

仪表板允许您编辑 iSCSI 目标。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- Ceph iSCSI 网关安装至少有两个网关。

- iSCSI 网关添加到仪表板中。

- 启用仪表板 iSCSI 功能。

- 启用了 RBD 应用的复制池。

- 启用了 RBD 应用的纠删代码池。

- 已创建一个 iSCSI 目标。

流程

- 登录到仪表板。

- 在导航栏中,单击 Block。

点击 iSCSI :

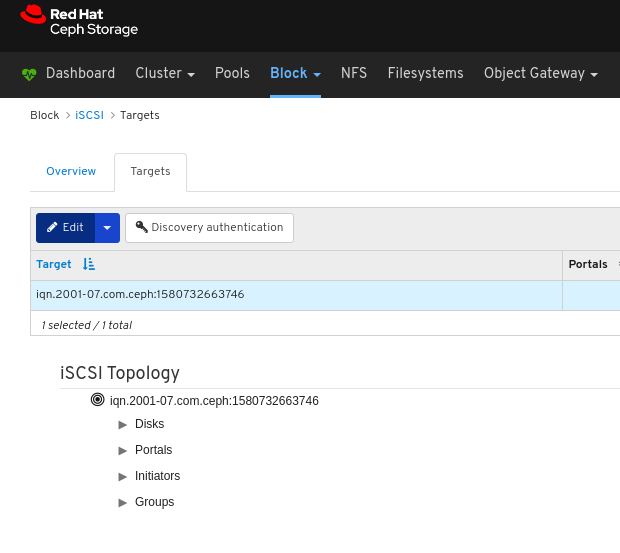

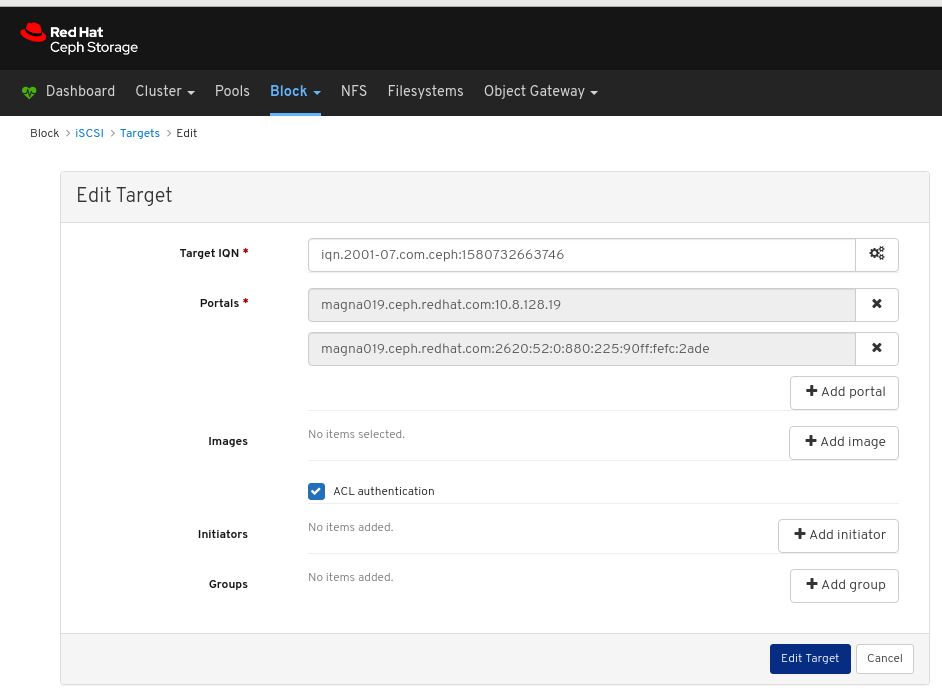

在页面的左上角点击 Targets 选项卡:

要编辑目标,请点击其行:

在页面的左上角,单击 Edit 按钮。

编辑参数并点 编辑目标 按钮。

在 Targets 页面中查找目标,以验证是否已编辑该目标。

要找到 Targets 页面,请按照 控制面板指南中的 查看 iSCSI 目标 的步骤。

其它资源

- 有关如何安装 Ceph iSCSI 网关的详情,请参考 《块设备指南》 中的 安装 iSCSI 网关。

- 有关如何在控制面板中添加 iSCSI 网关的详情,请参考控制面板中 手动将 iSCSI 网关添加到仪表板中。https://access.redhat.com/documentation/en-us/red_hat_ceph_storage/4/html-single/dashboard_guide/

- 有关如何启用控制面板 iSCSI 功能的详情 ,请参考 控制面板指南中的 启用仪表板 iSCSI 功能。

- 有关如何创建启用了 RBD 应用的池的信息,请参阅《 块设备 指南》中的创建块设备 池

- 有关如何创建镜像的详情,请参考在块设备 指南中创建块设备镜像。

9.4.7. 删除 iSCSI 目标

仪表板允许您删除 iSCSI 目标。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装控制面板。

- Ceph iSCSI 网关安装至少有两个网关。

- iSCSI 网关添加到仪表板中。

- 启用仪表板 iSCSI 功能。

- 已创建一个 iSCSI 目标。

- 断开所有 iSCSI 启动器。请参阅 断开 iSCSI 启动器。

流程

- 登录到仪表板。

- 在导航栏中,单击 Block。

点击 iSCSI :

在页面的左上角点击 Targets 选项卡:

要删除某个目标,请点击其行:

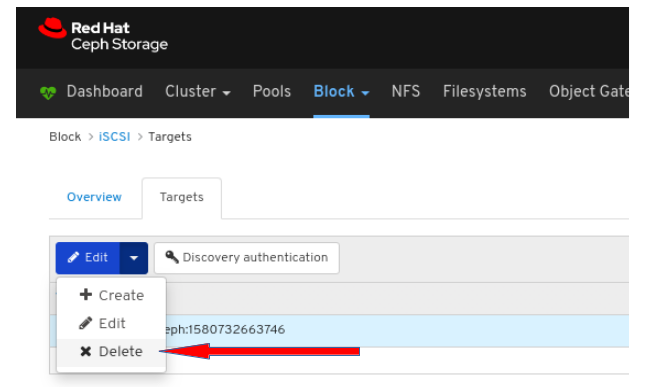

- 在页面的左上角,单击 Edit 下拉菜单。

从下拉菜单中,选择 Delete:

单击 是,我确定 框,然后单击 Delete iSCSI 以保存设置。

其它资源

- 有关如何安装 Ceph iSCSI 网关的详情,请参考 《块设备指南》 中的 安装 iSCSI 网关。