对象网关指南

部署、配置和管理 Ceph 对象网关

摘要

第 1 章 Ceph 对象网关

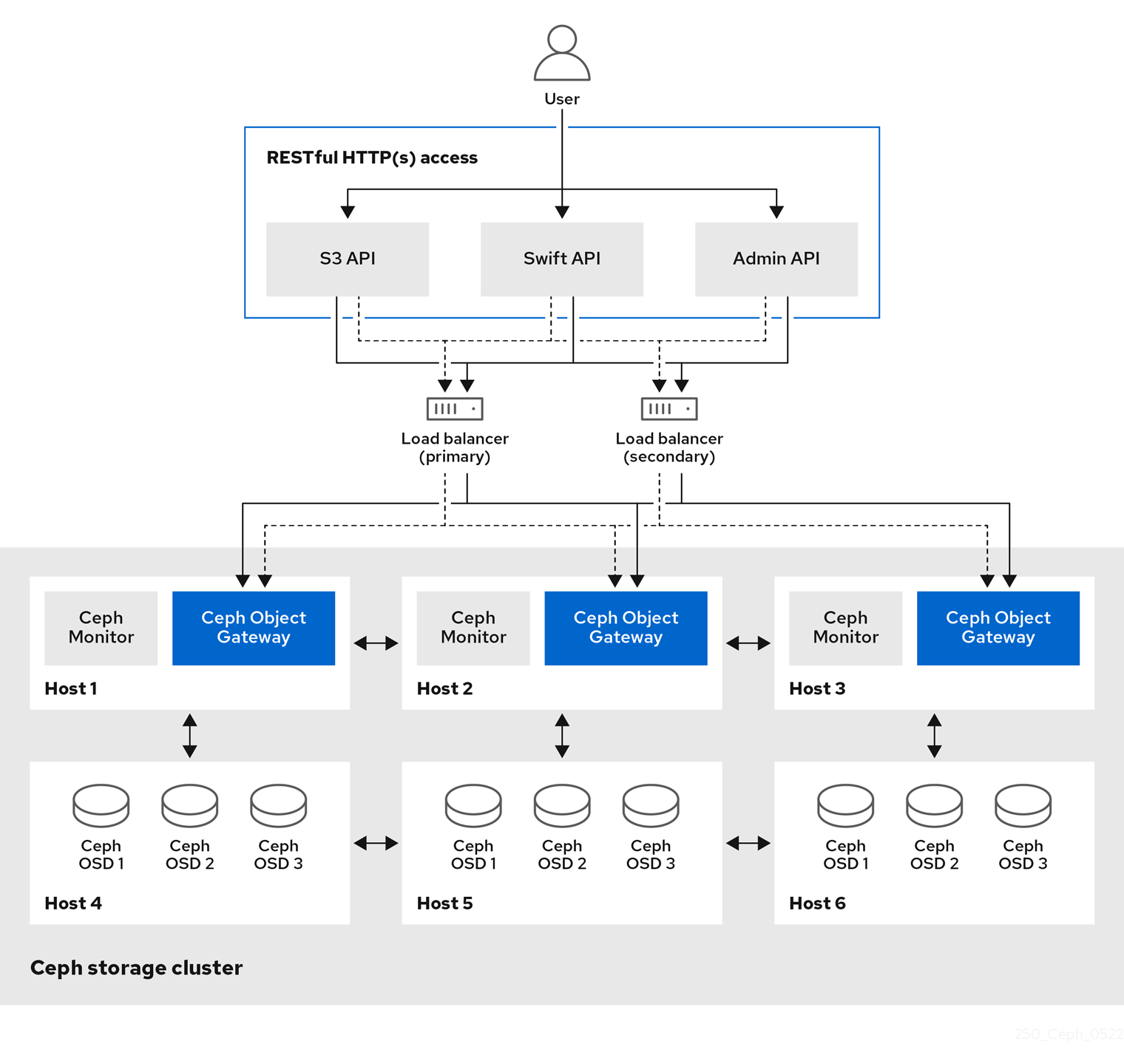

Ceph 对象网关(也称为 RADOS 网关(RGW))是在 librados 库基础上构建的对象存储接口,为应用提供 Ceph 存储群集的 RESTful 网关。Ceph 对象网关支持三个接口:

S3 兼容性:

通过与 Amazon S3 RESTful API 的大子集兼容的接口提供对象存储功能。

Swift 兼容性:

通过与 OpenStack Swift API 的大集兼容的接口提供对象存储功能。

Ceph 对象网关是一种与 Ceph 存储群集交互的服务。由于它提供与 OpenStack Swift 和 Amazon S3 兼容的接口,Ceph 对象网关拥有自己的用户管理系统。Ceph 对象网关可以将数据存储到同一个 Ceph 存储群集中,用于存储来自 Ceph 块设备客户端的数据;但是,它将涉及单独的池,可能会涉及到不同的 CRUSH 层次结构。S3 和 Swift API 共享一个通用命名空间,因此您可以使用一个 API 写入数据并与其他 API 检索数据。

管理 API:

提供用于管理 Ceph 对象网关的管理界面。

管理 API 请求在以 admin 资源端点开头的 URI 上执行。管理 API 的授权模仿 S3 授权约定。有些操作要求用户具有特殊的管理功能。响应类型可以是 XML 或 JSON,方法是在请求中指定 format 选项,但默认为 JSON 格式。

第 2 章 注意事项和建议

作为存储管理员,运行 Ceph 对象网关并实施多站点 Ceph 对象网关解决方案之前需要考虑哪些内容非常重要。您可以了解硬件和网络要求,了解哪种类型的工作负载适合 Ceph 对象网关,以及红帽的建议。

2.1. 先决条件

- 了解、考虑和规划存储解决方案的时间.

2.2. Red Hat Ceph Storage 的网络注意事项

云存储解决方案的一个重要方面是存储集群可能会因为网络延迟及其他因素而耗尽 IOPS。另外,存储集群可能会因为带宽限制而无法在存储集群用尽存储容量前耗尽吞吐量。这意味着网络硬件配置必须支持所选工作负载,以满足价格与性能要求。

存储管理员希望存储集群尽快恢复。仔细考虑存储集群网络的带宽要求、通过订阅的网络链接,以及隔离客户端到集群流量的集群内部流量。在考虑使用 Solid State Disks(SSD)、闪存、NVMe 和其他高性能存储设备时,还需要考虑到网络性能变得越来越重要。

Ceph 支持公共网络和存储集群网络。公共网络处理客户端流量以及与 Ceph 监控器的通信。存储集群网络处理 Ceph OSD 心跳、复制、回填和恢复流量。至少,单个 10 Gb/s 以太网链接应该用于存储硬件,您可以为连接和吞吐量添加额外的 10 Gb/s 以太网链接。

红帽建议将带宽分配给存储集群网络,使其成为使用 osd_pool_default_size 的倍数,作为池上多个的基础。红帽还建议在单独的网卡中运行公共和存储集群网络。

红帽建议在生产环境中使用 10 Gb/s 以太网部署 Red Hat Ceph Storage。1 Gb/s 以太网网络不适用于生产环境的存储集群。

如果出现驱动器故障,在 1 Gb/s 网络中复制 1 TB 数据需要 3 小时,在 1 Gb/s 网络中复制 10 TB 数据需要 30 小时。使用 10 TB 是典型的驱动器配置。与之相反,使用 10 Gb/s 以太网网络,复制时间为 20 分钟(1 TB),1 小时(10 TB)。请记住,当 Ceph OSD 出现故障时,存储集群通过将包含的数据复制到同一故障域中其他 OSD,以及作为故障 OSD 的设备类来恢复。

对于大型环境(如机架)的故障,意味着存储集群将使用的带宽要高得多。在构建由多个机架组成的存储群集(对于大型存储实施常见)时,应考虑在"树树"设计中的交换机之间利用尽可能多的网络带宽,以获得最佳性能。典型的 10 Gb/s 以太网交换机有 48 个 10 Gb/s 端口和四个 40 Gb/s 端口。使用 40 Gb/s 端口以获得最大吞吐量。或者,考虑将未使用的 10 Gb/s 端口与 QSFP+ 和 SFP+ 电缆聚合到 40 Gb/s 端口,以连接到其他机架和机发路由器。此外,还要考虑使用 LACP 模式 4 来绑定网络接口。另外,使用巨型帧,最大传输单元(MTU)为 9000,特别是在 backend 或 cluster 网络中。

在安装和测试 Red Hat Ceph Storage 集群之前,请验证网络吞吐量。Ceph 中大多数与性能相关的问题通常是因为网络问题造成的。简单的网络问题(如粒度或 Bean Cat-6 电缆)可能会导致带宽下降。至少 10 Gb/s ethernet 用于前端网络。对于大型集群,请考虑将 40 Gb/s ethernet 用于后端或集群网络。

为了优化网络,红帽建议使用巨型帧来获得更高的每带宽比率的 CPU,以及一个非阻塞的网络交换机后端。Red Hat Ceph Storage 在通信路径的所有网络设备中,公共和集群网络需要相同的 MTU 值。在在生产环境中使用 Red Hat Ceph Storage 集群之前,验证环境中所有主机和网络设备上的 MTU 值相同。

2.3. Red Hat Ceph Storage 的基本注意事项

使用 Red Hat Ceph Storage 的第一个考虑因素是为数据制定存储策略。存储策略是一种存储服务特定用例的数据的方法。如果您需要为 OpenStack 等云平台存储卷和镜像,可以选择将数据存储在带有 Solid State Drives (SSD) 的快速 Serial Attached SCSI (SAS) 驱动器上。相反,如果您需要存储 S3 或 Swift 兼容网关的对象数据,您可以选择使用更经济的方式,如传统的 SATA 驱动器。Red Hat Ceph Storage 可以在同一存储集群中同时容纳这两种场景,但您需要一种方式为云平台提供快速存储策略,并为对象存储提供更传统的存储方式。

一个成功的 Ceph 部署中的最重要的一个步骤是,找出一个适合存储集群的用例和工作负载的性价比配置集。为用例选择正确的硬件非常重要。例如,为冷存储应用程序选择 IOPS 优化的硬件会不必要地增加硬件成本。然而,在 IOPS 密集型工作负载中,选择容量优化的硬件使其更具吸引力的价格点可能会导致用户对性能较慢的抱怨。

Red Hat Ceph Storage 可以支持多种存储策略。用例、成本与好处性能权衡以及数据持久性是帮助开发合理存储策略的主要考虑因素。

使用案例

Ceph 提供大量存储容量,它支持许多用例,例如:

- Ceph 块设备客户端是云平台的领先存储后端,可为具有写时复制(copy-on-write)克隆等高性能功能的卷和镜像提供无限存储。

- Ceph 对象网关客户端是云平台的领先存储后端,为音频、位映射、视频和其他数据等对象提供 RESTful S3 兼容和 Swift 兼容对象存储。

- 传统文件存储的 Ceph 文件系统.

成本比较性能优势

越快越好。越大越好。越耐用越好。但是,每种出色的质量、相应的成本与收益权衡都有价格。从性能角度考虑以下用例:SSD 可以为相对较小的数据和日志量提供非常快速的存储。存储数据库或对象索引可以从非常快的 SSD 池中受益,但对于其他数据而言成本过高。带有 SSD 日志的 SAS 驱动器以经济的价格为卷和图像提供快速性能。没有 SSD 日志地 SATA 驱动器可提供低成本存储,同时整体性能也较低。在创建 OSD 的 CRUSH 层次结构时,您需要考虑用例和可接受的成本与性能权衡。

数据持续时间

在大型存储集群中,硬件故障是预期的,而非例外。但是,数据丢失和服务中断仍然不可接受。因此,数据的持久性非常重要。Ceph 通过对象的多个副本解决数据持久性问题,或使用纠删代码和多个编码区块来解决数据持久性。多个副本或多个编码区块会带来额外的成本与好处权衡:存储更少的副本或编码区块会更便宜,但可能会导致在降级状态中为写入请求提供服务。通常,一个具有两个额外副本的对象(或两个编码区块)可以允许存储集群在存储集群恢复时服务降级状态的写入。

在出现硬件故障时,复制存储在故障域中的一个或多个数据冗余副本。但是,冗余的数据副本规模可能会变得昂贵。例如,要存储 1 PB 字节并带有三倍复制的数据,将需要至少具有 3 PB 存储容量的集群。

纠删代码将数据存储为数据区块和编码区块。如果数据区块丢失,纠删代码可以使用剩余的数据区块和编码区块来恢复丢失的数据区块。纠删代码比复制更经济。例如,使用带有 8 个数据区块和 3 个编码区块的纠删代码提供与 3 个数据副本相同的冗余。但是,与复制相比(使用 3 倍的初始数据),此类编码方案使用约 1.5 倍的初始数据。

CRUSH 算法通过确保 Ceph 将额外的副本或编码区块存储在存储集群内的不同位置来协助这个过程。这样可确保单个存储设备或主机的故障不会丢失防止数据丢失所需的所有副本或编码区块。您可以规划一个成本取舍存储策略,以及数据持久性,然后将它作为存储池呈现给 Ceph 客户端。

数据存储池可以使用纠删代码。存储服务数据和存储桶索引的池使用复制。

与 Ceph 的对象复制或编码区块相比,RAID 解决方案已变得过时。不要使用 RAID,因为 Ceph 已经处理数据持久性,降级的 RAID 对性能有负面影响,并且使用 RAID 恢复数据比使用深度副本或纠删代码区块要慢得多。

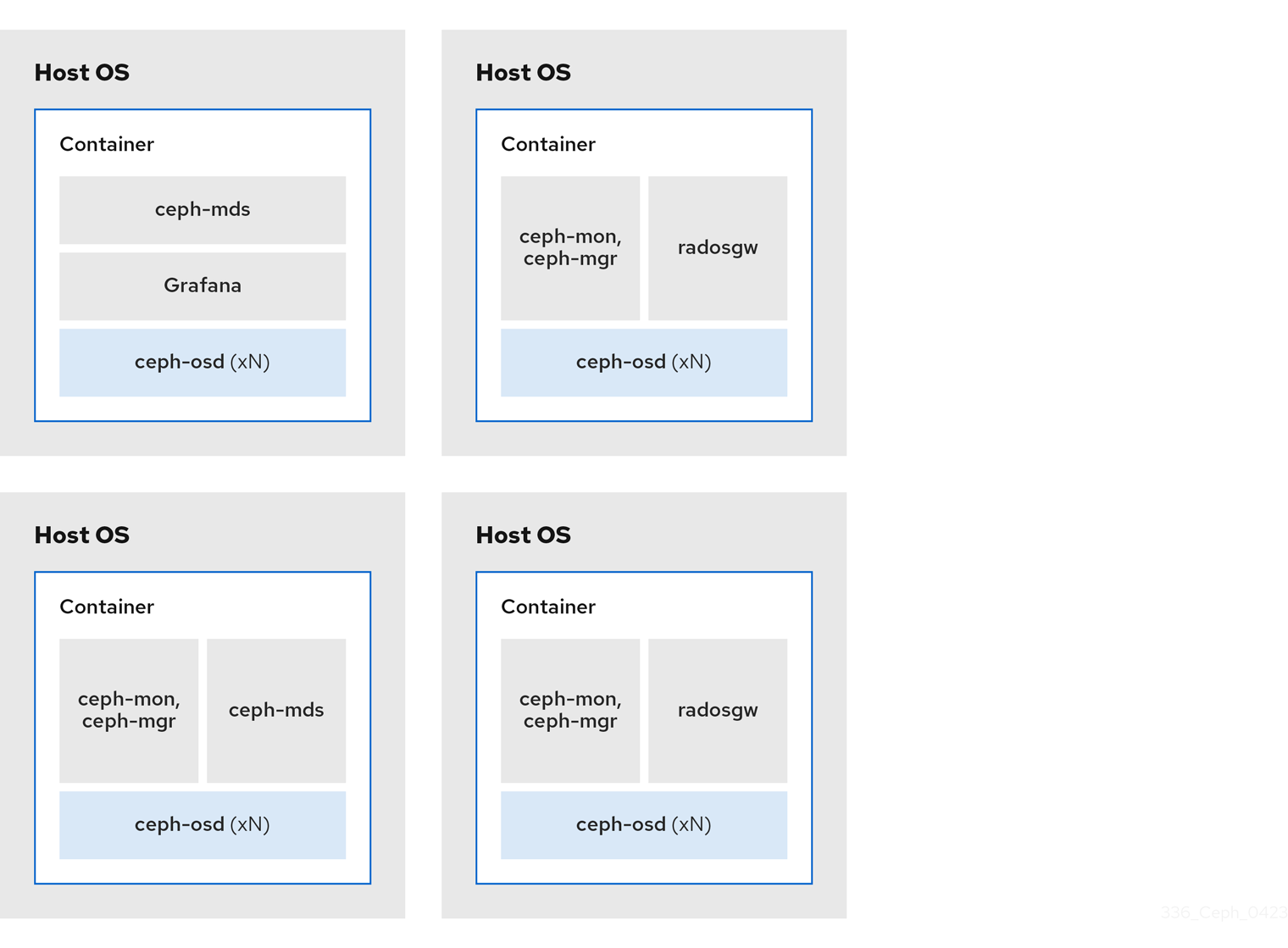

2.3.1. Colocating Ceph 守护进程及其优点

您可以在同一主机上并置容器化 Ceph 守护进程。以下是查找一些 Ceph 守护进程的优点:

- 在小规模上显著改善了总拥有成本(TCO)。

- 可以提高整体性能。

- 减少用于最小配置的物理主机数量。

- 更好地利用资源。

- 升级 Red Hat Ceph Storage 更为容易。

通过使用容器,您可以将以下列表中的一个守护进程与 Ceph OSD 守护进程共存(ceph-osd)。此外,对于 Ceph 对象网关(radosgw)、Ceph 元数据服务器(ceph-mds)和 Grafana,您可以将它与 Ceph OSD 守护进程并置,以及以下列表中的守护进程。

-

Ceph 元数据服务器 (

ceph-mds) -

Ceph monitor(

ceph-mon) -

Ceph Manager(

ceph-mgr) -

NFS Ganesha (

nfs-ganesha) -

Ceph 管理器(

ceph-grafana)

| 主机名 | Daemon | Daemon | Daemon |

|---|---|---|---|

| host1 | OSD | monitor & Manager | Prometheus |

| host2 | OSD | monitor & Manager | RGW |

| host3 | OSD | monitor & Manager | RGW |

| host4 | OSD | Metadata Server | |

| host5 | OSD | Metadata Server |

由于 ceph-mon 和 ceph-mgr 协同工作,所以它们不会被视为 colocation 认为两个独立的守护进程。

通过 --placement 选项对 ceph 或ch 命令使用 --placement 选项,或使用服务规格 YAML 文件,即可通过命令行界面完成 Ceph 守护进程。

命令行示例

[ceph: root@host01 /]# ceph orch apply mon --placement="host1 host2 host3"

[ceph: root@host01 /]# ceph orch apply mon --placement="host1 host2 host3"服务规格 YAML 文件示例

[ceph: root@host01 /]# ceph orch apply -i mon.yml

[ceph: root@host01 /]# ceph orch apply -i mon.yml红帽建议将 Ceph 对象网关与 Ceph OSD 容器共存以提高性能。要在不产生额外的硬件成本的情况下获得最高性能,请在每个主机使用两个 Ceph 对象网关守护进程。

Ceph 对象网关命令行示例

[ceph: root@host01 /]# ceph orch apply rgw example --placement="6 host1 host2 host3"

[ceph: root@host01 /]# ceph orch apply rgw example --placement="6 host1 host2 host3"Ceph 对象网关服务规格 YAML 文件示例

[ceph: root@host01 /]# ceph orch apply -i rgw.yml

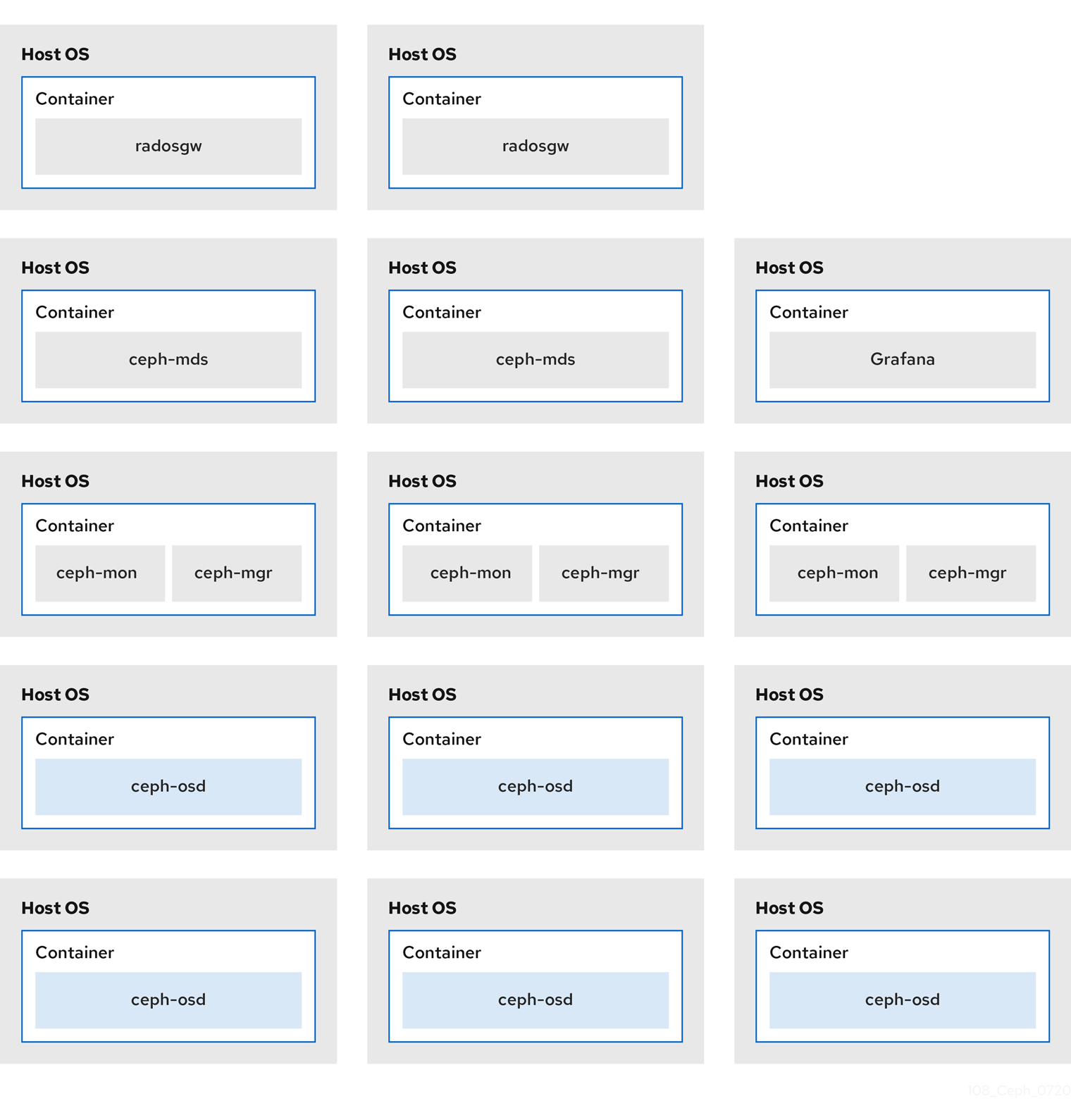

[ceph: root@host01 /]# ceph orch apply -i rgw.yml下图显示了具有并置守护进程和非并置守护进程的存储集群之间的区别。

图 2.1. colocated Daemons

图 2.2. 非并置守护进程

2.4. Red Hat Ceph Storage 工作负载注意事项

Ceph 存储集群的一个关键优势在于能够使用性能域支持同一存储集群中的不同类型的工作负载。不同的硬件配置可以与每个性能域关联。存储管理员可以在适当的性能域中部署存储池,为应用提供专为特定性能和成本配置文件量身定制的存储。为这些性能域选择适当的大小和优化的服务器是设计 Red Hat Ceph Storage 集群的一个重要方面。

在读取和写入数据的 Ceph 客户端接口中,Ceph 存储集群显示为一个客户端存储数据的简单池。但是,存储集群以对客户端接口完全透明的方式执行许多复杂的操作。Ceph 客户端和 Ceph 对象存储守护进程(称为 Ceph OSD 或只是 OSD)都使用可扩展哈希下的受控复制(Control)算法来存储和检索对象。Ceph OSD 可以在存储集群内的容器中运行。

CRUSH map 描述了集群资源的拓扑结构,并且 map 存在于客户端主机和集群中的 Ceph 监控主机中。Ceph 客户端和 Ceph OSD 都使用 CRUSH map 和 CRUSH 算法。Ceph 客户端直接与 OSD 通信,消除了集中式对象查找和潜在的性能瓶颈。利用 CRUSH map 并与其对等方通信,OSD 可以处理复制、回填和恢复,从而实现动态故障恢复。

Ceph 使用 CRUSH map 来实施故障域。Ceph 还使用 CRUSH map 实施性能域,这只需将底层硬件的性能配置文件纳入考量。CRUSH map 描述了 Ceph 存储数据的方式,它作为简单的层次结构(特别是圆环图和规则集)实施。CRUSH map 可以支持多种层次结构,将一种类型的硬件性能配置集与另一类分隔开。Ceph 实施具有设备"类"的性能域。

例如,您可以让这些性能域共存在同一 Red Hat Ceph Storage 集群中:

- 硬盘 (HDD) 通常适合以成本和容量为导向的工作负载。

- 吞吐量敏感的工作负载通常使用 HDD,在固态驱动器 (SSD) 上 Ceph 写入日志。

- MySQL 和 MariaDB 等 IOPS 密集型工作负载通常使用 SSD。

图 2.3. 性能和故障域

工作负载

Red Hat Ceph Storage 针对三种主要工作负载进行了优化:

在购买硬件前,请仔细考虑由 Red Hat Ceph Storage 运行的工作负载,因为它可能会显著影响存储集群的价格和性能。例如,如果工作负载是容量优化的,并且硬件更适合通过吞吐量优化的工作负载,则硬件的成本将超过必要成本。相反,如果工作负载被优化吞吐量,且硬件更适合容量优化的工作负载,则存储集群的性能会受到影响。

优化 IOPS: IOPS(Input, output per second)优化部署适合云计算操作,例如将 MYSQL 或 MariaDB 实例作为 OpenStack 上的虚拟机运行。优化 IOPS 部署需要更高的性能存储,如 15k RPM SAS 驱动器和单独的 SSD 日志,以处理频繁的写入操作。一些高 IOPS 情景使用所有闪存存储来提高 IOPS 和总吞吐量。

IOPS 优化存储集群具有以下属性:

- 每个 IOPS 的成本最低。

- 每 GB 的 IOPS 最高。

- 99 个百分点延迟一致性.

IOPS 优化存储集群的用例:

- 典型的块存储.

- 用于硬盘 (HDD) 或 2x 复制的 3 倍复制,用于固态硬盘 (SSD)。

- OpenStack 云上的 MySQL.

优化吞吐量:使用优化吞吐量的部署适合服务大量数据,如图形、音频和视频内容。优化吞吐量的部署需要高带宽网络硬件、控制器和硬盘,具有快速顺序的读写特征。如果要求快速数据访问,则使用吞吐量优化存储策略。此外,如果要求快速写入性能,将 Solid State Disk (SSD) 用于日志将显著提高写入性能。

吞吐量优化存储集群具有以下属性:

- 每 MBps 成本最低(吞吐量)。

- 每个 TB 的 MBps 最高。

- 每个 BTU 的 MBps 最高。

- 每个 Watt 的 MBps 最高。

- 97% 的延迟一致性.

用于吞吐量优化的存储集群有:

- 块或对象存储。

- 3 倍复制。

- 面向视频、音频和图像的主动性能存储.

- 流媒体,如 4k 视频.

优化容量: 容量优化部署适合以尽可能低的成本存储大量数据。容量优化的部署通常会以更具吸引力的价格点来换取性能。例如,容量优化部署通常使用速度较慢且成本更低的 SATA 驱动器和共同定位日志,而不是使用 SSD 进行日志。

成本和容量优化的存储集群具有以下属性:

- 每 TB 成本最低。

- 每 TB 的 BTU 最低。

- 每 TB 的 Watts 最低.

用于成本和容量优化的存储集群有:

- 典型的对象存储.

- 纠删代码,以最大程度地提高可用容量

- 对象存档。

- 视频、音频和图像对象存储库.

2.5. Ceph 对象网关注意事项

设计存储集群的另一个重要方面是确定存储集群会位于一个数据中心站点,还是跨越多个数据中心站点。多站点存储群集得益于地理分散的故障切换和灾难恢复,如长期停电、农业、风暴、风暴、水水或其他灾难。另外,多站点存储群集可以具有主动配置,该配置可将客户端应用定向到最接近的可用存储集群。这是内容交付网络的一个好存储策略。考虑尽可能将数据放置在客户端附近。这对吞吐量密集型工作负载(如流 4k 视频)非常重要。

红帽建议识别域、zone group 和 zone 名称 BEFORE 创建 Ceph 的存储池。使用区域名称作为标准命名约定附加一些池名称。

2.5.1. 管理数据存储

Ceph 对象网关将管理数据存储在实例的区域配置中定义的一系列池中。例如,后续小节中讨论的 bucket、用户、用户配额和用量统计存储在 Ceph 存储集群的池中。默认情况下,Ceph 对象网关会创建以下池并将其映射到默认区域。

-

.rgw.root -

.default.rgw.control -

.default.rgw.meta -

.default.rgw.log -

.default.rgw.buckets.index -

.default.rgw.buckets.data -

.default.rgw.buckets.non-ec

只有 Ceph 对象网关中创建 bucket 之后,才会创建 .default.rgw.buckets.index 池,而数据上传到 bucket 后才会创建 .default.rgw.buckets.data 池。

考虑手动创建这些池,以便您可以设置 CRUSH 规则集和放置组的数量。在典型的配置中,存储 Ceph 对象网关管理数据的池通常使用相同的 CRUSH 规则集,并且使用较少的 PG,因为管理数据有 10 个池。

红帽建议 .rgw.root 池和服务池使用相同的 CRUSH 层次结构,并且至少将 node 用作 CRUSH 规则中的故障域。红帽建议将 复制 用于数据持久性,而不要删除 .rgw.root 池和服务池。

如果您将太多 PG 分配给池,mon_pg_warn_max_per_osd 设置将发出警告,默认为 300。您可以调整值以满足您的需求和硬件的功能,其中 n 是每个 OSD 的最大 PG 数。

mon_pg_warn_max_per_osd = n

mon_pg_warn_max_per_osd = n

对于包括 .rgw.root 在内的服务池,每个池计算器的 Ceph 放置组(PG) 建议的 PG 数显著低于每个 Ceph OSD 的目标 PG。此外,还要确保计算器的第 4 步中设置 Ceph OSD 的数量。

垃圾回收使用带有常规 RADOS 对象的 .log 池,而不是 OMAP。在未来的发行版中,更多功能会将元数据存储到 .log 池。因此,红帽建议将 NVMe/SSD Ceph OSD 用于 .log 池。

.rgw.root 池

存储 Ceph 对象网关配置的池。这包括 realms、zone group 和 zones。按照惯例,其名称不会以区域名称开头。

服务池

服务池存储与服务控制、垃圾收集、日志记录、用户信息和使用量相关的对象。按照惯例,这些池名称的前置为池名称的区域名称。

-

.ZONE_NAME.rgw.control: 控制池。 -

.ZONE_NAME.log:日志池包含所有存储桶、容器和对象操作的日志,如 create、read、update 和 delete。 -

.ZONE_NAME.rgw.buckets.index:此池存储存储桶的索引。 -

.ZONE_NAME.rgw.buckets.data:此池存储存储桶的数据。 -

.ZONE_NAME.rgw.meta:元数据池存储 user_keys 和其他关键元数据。 -

.ZONE_NAME.meta:users.uid:用户 ID 池包含唯一用户 ID 的映射。 -

.ZONE_NAME.meta:users.keys:密钥池包含每个用户 ID 的访问密钥和密钥。 -

.ZONE_NAME.meta:users.email:电子邮件池包含与用户 ID 关联的电子邮件地址。 -

.ZONE_NAME.meta:users.swift:Swift 池包含用于用户 ID 的 Swift 子用户信息。

2.5.2. 索引池

当选择用于 Ceph 对象网关的 OSD 硬件时,无论存储索引池,都需要至少一个具有至少一个高性能驱动器的 OSD 节点(一个 SSD 或 NVMe 驱动器)。当 bucket 包含大量对象时,这一点尤为重要。

对于运行 Bluestore 的 Red Hat Ceph Storage,红帽建议将 NVMe 驱动器部署为 block.db 设备,而不是作为单独的池。

Ceph 对象网关索引数据仅写入对象映射(OMAP)中。BlueStore 的 OMAP 数据位于 OSD 上的 block.db 设备上。当 NVMe 驱动器作为 HDD OSD 的 block.db 设备以及由 HDD OSD 支持时,索引数据将完全写入 block.db 设备。只要 block.db 分区/lvm 大小正确为块的 4%,这个配置都是 BlueStore 所需要的。

红帽不支持索引池的 HDD 设备。如需有关支持的配置的更多信息,请参阅 Red Hat Ceph Storage: 支持的配置 文章。

索引条目大约 200 字节的数据,作为 OMAP 存储在 rocksdb 中。虽然这是少量数据,但一些 Ceph 对象网关的使用可能会导致单个存储桶中的几百个对象或几百以百万计的对象。通过将索引池映射到具有高性能存储介质的 CRUSH 层次结构,当 bucket 包含大量对象时,对则延的减小会显著提高性能。

在生产环境集群中,典型的 OSD 节点至少有一个 SSD 或 NVMe 驱动器来存储 OSD 日志和索引池或 block.db 设备,后者将单独的分区或逻辑卷用于同一个物理驱动器。

2.5.3. 数据池

数据池是 Ceph 对象网关存储特定存储策略的对象数据的位置。数据池具有完整放置组 (PG) ,而不是用于服务池的数量减少的 PG。考虑将纠删代码用于数据池,因为它比复制更高效,而且可以显著降低容量要求,同时保持数据持久性。

要使用纠删代码,请创建一个纠删代码 profile。如需了解更多详细信息,请参阅 Red Hat Ceph Storage Storage 策略指南中的 Erasure Code Profiles 部分。

选择正确的配置集非常重要,因为您创建池后无法更改配置集。若要修改配置文件,您必须创建一个具有不同配置文件的新池,并将对象从旧池中迁移到新池中。

默认配置是两个数据块(k)和两个编码区块(m),这意味着只能丢失一个 OSD。对于更高的弹性,请考虑大量数据和编码区块。例如,一些大型系统使用 8 个数据区块和 3 个编码块,这允许 3 个 OSD 在不丢失数据的情况下失败。

每个数据和编码区块 SHOULD 至少会存储在不同的节点或主机上。对于较小的存储集群,这会导致将 机架 式用作最少的 CRUSH 故障域,用于大量数据和编码块。因此,数据池通常使用单独的 CRUSH 层次结构并将 主机 用作最小 CRUSH 故障域。红帽建议 host 作为最小故障域。如果纠删代码池区块在同一主机上的 Ceph OSD 上存储,则主机故障(如失败的日志或网卡)可能会导致数据丢失。

若要创建数据池,运行 ceph osd pool create 命令,使用池名称、PG 和 PGP 的数量、erasure 数据持久性方法、纠删代码 profile 和规则名称。

2.5.4. 数据额外池

data_extra_pool 用于无法使用纠删代码的数据。例如,多部分上传允许上传大型对象,例如在多个部分中进行移动。这些部分必须首先存储而无纠删代码。擦除编码适用于整个对象,而非部分上传。

每个池的 PG 数量约为 data_extra_pool 的每个池的 PG 数量(PG);但 PG 计数大约是服务池的 PG 数量两倍,与 bucket 索引池相同。

要创建数据额外池,使用池名称运行 ceph osd pool create 命令、Clemans 和 PGP 的数量、复制的 数据持久性方法以及规则的名称。例如:

ceph osd pool create .us-west.rgw.buckets.non-ec 64 64 replicated rgw-service

# ceph osd pool create .us-west.rgw.buckets.non-ec 64 64 replicated rgw-service2.6. 开发 CRUSH 层次结构

作为存储管理员,在部署 Ceph 存储集群和对象网关时,通常 Ceph 对象网关具有默认的 zone group 和 zone。Ceph 存储群集将具有默认的池,后者使用 CRUSH 层次结构和默认 CRUSH 规则的 CRUSH map。

默认 rbd 池可以使用默认的 CRUSH 规则。如果 Ceph 客户端已使用它们存储客户端数据,请不要 删除 默认规则或层次结构。

生产网关通常使用自定义域、zone group 和 zone,具体取决于网关的使用和地理位置。此外,Ceph 存储群集将具有具有多个 CRUSH 层次结构的 CRUSH map。

-

服务池: 至少一个 CRUSH 层次结构将用于服务池,并且可能用于数据。服务池包含

.rgw.root以及与区域关联的服务池。服务池通常位于单个 CRUSH 层次结构下,并使用复制来实现数据持久性。数据池也可能使用 CRUSH 层次结构,但池通常配置有纠删代码以实现数据持久性。 - index : 至少将一个 CRUSH 层次结构 SHOULD 用于索引池,其中 CRUSH 层次结构映射到高性能介质,如 SSD 或 NVMe 驱动器。bucket 索引可能会成为性能瓶颈。红帽建议在 CRUSH 层次结构中使用 SSD 或 NVMe 驱动器。在用于 Ceph OSD 日志的 SSD 或 NVMe 驱动器上创建索引分区。另外,索引应该配置有存储桶分片。

- placement Pools: 每个放置目标的池包括存储桶索引、数据存储桶和 bucket 额外。这些池可以属于单独的 CRUSH 层次结构。由于 Ceph 对象网关可以支持多个存储策略,因此存储策略的存储桶池可能与不同的 CRUSH 层次结构关联,反映不同的用例,如 IOPS 优化、吞吐量和容量优化等。bucket 索引池 SHOULD 使用自己的 CRUSH 层次结构将 bucket 索引池映射到更高的性能存储介质,如 SSD 或 NVMe 驱动器。

2.6.1. 创建 CRUSH root

从管理节点上的命令行,为各个 CRUSH 层次结构在 CRUSH map 中创建 CRUSH roots。必须 至少有一个 CRUSH 层次结构,用于可能也提供数据存储池的服务池。bucket 索引池的 SHOULD 至少是一个 CRUSH 层次结构,映射到高性能存储介质,如 SSD 或 NVMe 驱动器。

如需有关 CRUSH 层次结构的详细信息,请参见 Red Hat Ceph Storage 指南 5 中的 CRUSH 层次结构章节。

若要手动编辑 CRUSH map,请参阅 Red Hat Ceph Storage 策略指南 5 中的编辑 CRUSH map 部分。

在以下示例中,名为 data0、data1 和 data2 的主机使用扩展的逻辑名称,如 data0-sas -sd、data0-index 等等,因为有多个 CRUSH 层次结构指向同一物理主机。

典型的 CRUSH root 可能代表具有 SAS 驱动器和 SSD 的节点(用于日志)。例如:

用于 bucket 的 CRUSH root 索引 SHOULD 代表高性能介质,如 SSD 或 NVMe 驱动器。考虑在存储 OSD 日志的 SSD 或 NVMe 介质上创建分区。例如:

2.6.2. 创建 CRUSH 规则

与默认的 CRUSH 层次结构一样,CRUSH map 也包含默认的 CRUSH 规则。

默认 rbd 池可能使用此规则。如果其他池已使用它存储客户数据,请不要删除默认规则。

有关 CRUSH 规则的常规详情,请参见 Red Hat Ceph Storage 5 的 Red Hat Ceph Storage 策略指南中的 CRUSH 规则 部分。要手动编辑 CRUSH 映射,请参见 Red Hat Ceph Storage 5 的 Red Hat Ceph Storage Storage 策略指南中的 编辑 CRUSH map 部分。

对于每一 CRUSH 层次结构,创建一个 CRUSH 规则。下例演示了 CRUSH 层次结构的规则,该层次结构将存储服务池,包括 .rgw.root。在本例中,根 sas-ssd 充当 CRUSH 主层次结构。它使用名称 rgw-service 来区分其自身和默认规则。步骤取 sas- sd 行告知池使用在 Creating CRUSH roots 中创建的 sas-ssd root,其子存储桶包含带有 SAS 驱动器和高性能存储介质的 OSD,如 SSD 或 NVMe 驱动器(如 SSD 或 NVMe 驱动器)。step chooseleaf 的 type rack 部分是故障域。在以下示例中,这是一个机架。

在示例中,如果数据被复制三次,集群中的至少应该有三个机架,其中包含相似数量的 OSD 节点。

type replicated 设置与数据持久性、副本数或纠删代码 无关。仅支持 replicated。

下例演示了将存储数据池的 CRUSH 层次结构的规则。在本例中,根 sas-ssd 充当 CRUSH 主层次结构- 与服务规则相同的 CRUSH 层次结构。它使用 rgw-throughput 来区分其自身与默认规则和 rgw-service。步骤取 sas- sd 行告知池使用在 Creating CRUSH roots 中创建的 sas-ssd root,其子存储桶包含带有 SAS 驱动器和高性能存储介质的 OSD,如 SSD 或 NVMe 驱动器(如 SSD 或 NVMe 驱动器)。step chooseleaf 的 type host 部分是故障域。在以下示例中,这是主机。注意该规则使用相同的 CRUSH 层次结构,但使用了不同的故障realm。

在示例中,如果池将纠删代码与更多的数据进行纠删代码,且编码区块数超过默认值,则集群中的机架应至少包含数量相似的 OSD 节点,以便于纠删代码区块。对于较小的集群,这可能不实际,因此,示例中使用 host 作为 CRUSH 故障realm。

下例演示了 CRUSH 层次结构的规则,该规则将存储索引池。在本例中,根 index 充当 CRUSH 主层次结构。它使用 rgw-index 将自身与 rgw-service 和 rgw-throughput 区分开来。step take index 行告知池使用 Creating CRUSH Roots 创建 index root,其子存储桶包含高性能存储介质,如 SSD 或 NVMe 驱动器或 SSD 上存储 OSD 日志的 NVMe 驱动器或 NVMe 驱动器上。step chooseleaf 的 type rack 部分是故障域。在以下示例中,这是一个机架。

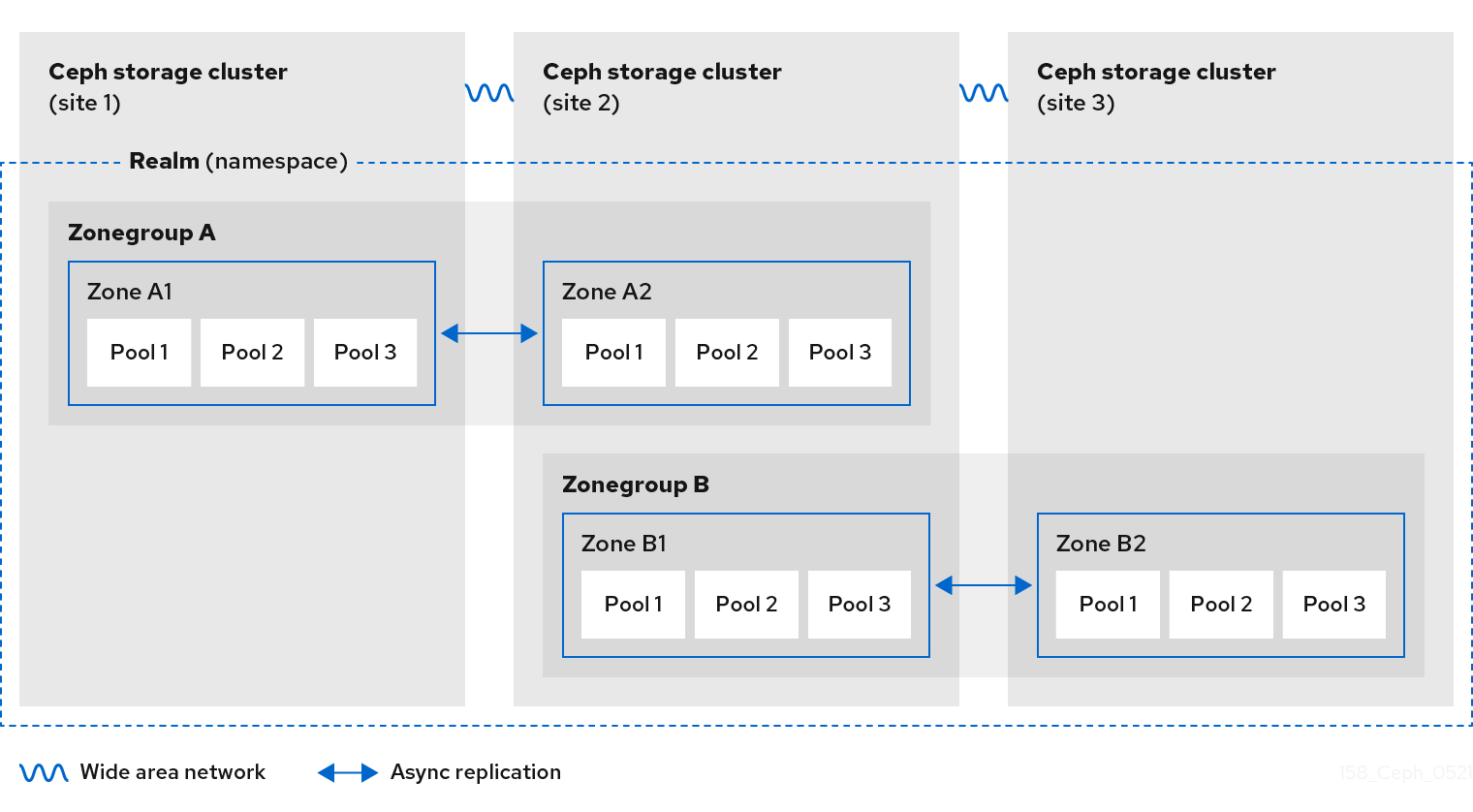

2.7. Ceph 对象网关多站点注意事项

Ceph 对象网关多站点配置至少需要两个红帽 Ceph 存储集群,并且至少有两个 Ceph 对象网关实例,每个红帽 Ceph 存储集群一个。通常,两个 Red Hat Ceph Storage 集群将在地理上独立的位置;但是,相同的多站点配置可以在位于同一物理站点的两个 Red Hat Ceph Storage 集群中工作。

多站点配置需要一个主要 zone group 和一个主要 zone。另外,每个 zone group 都需要一个主 zone。zone group 可能具有一个或多个次要区域。

域的主要 zone group 中的主要区域负责存储域元数据的主副本,包括用户、配额和 bucket。此元数据会自动同步到 second zone 和 second zone group。通过 FQDN -admin 命令行界面(CLI)MUST 发布的 元数据操作,在主 zone group 的主区区内发布,以确保它们与 second zone group 和 zone 同步。目前,可以对 second zone 和 zone group 分配元数据操作,但不建议这么做,因为它们无法同步,这可能导致元数据碎片。

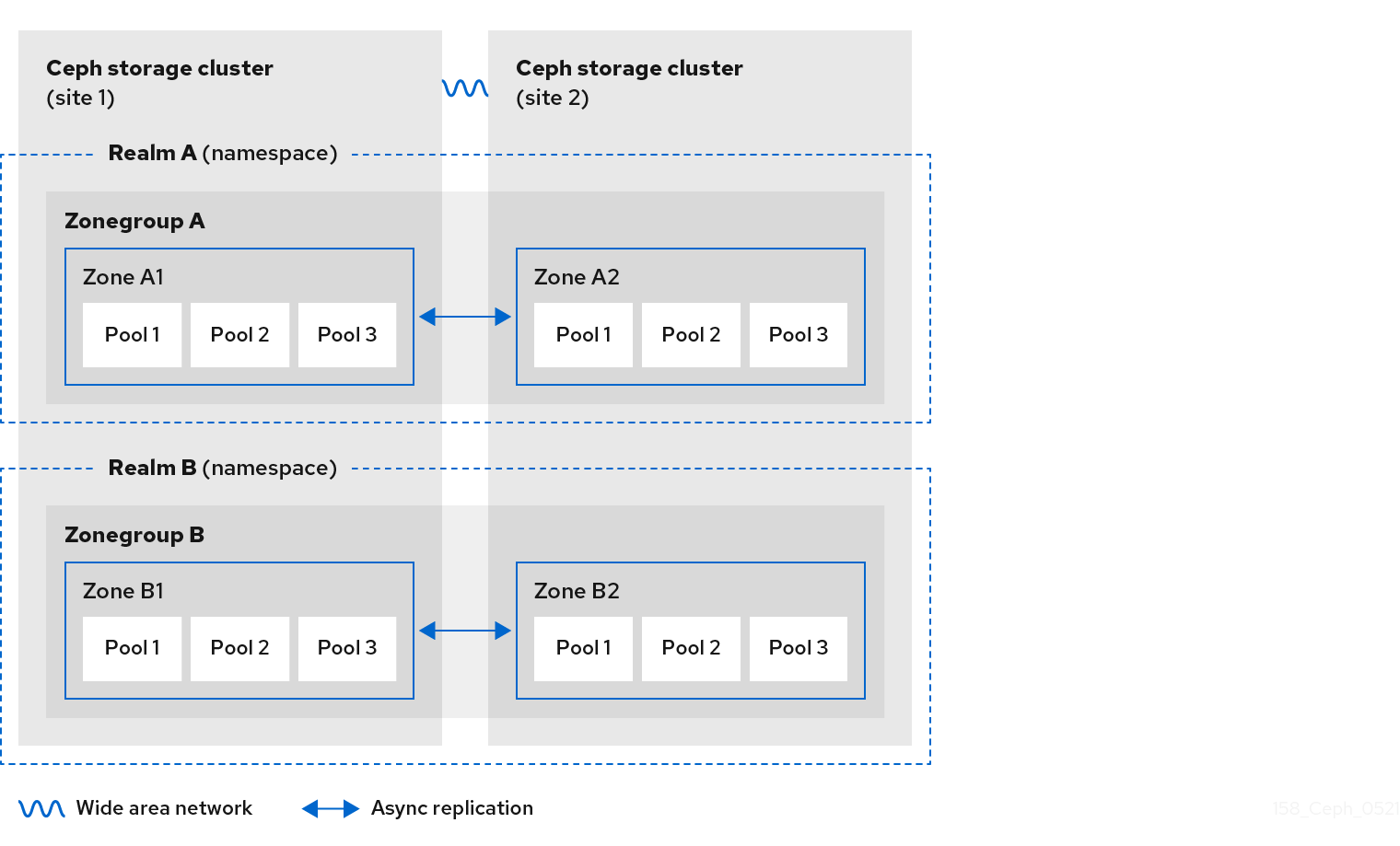

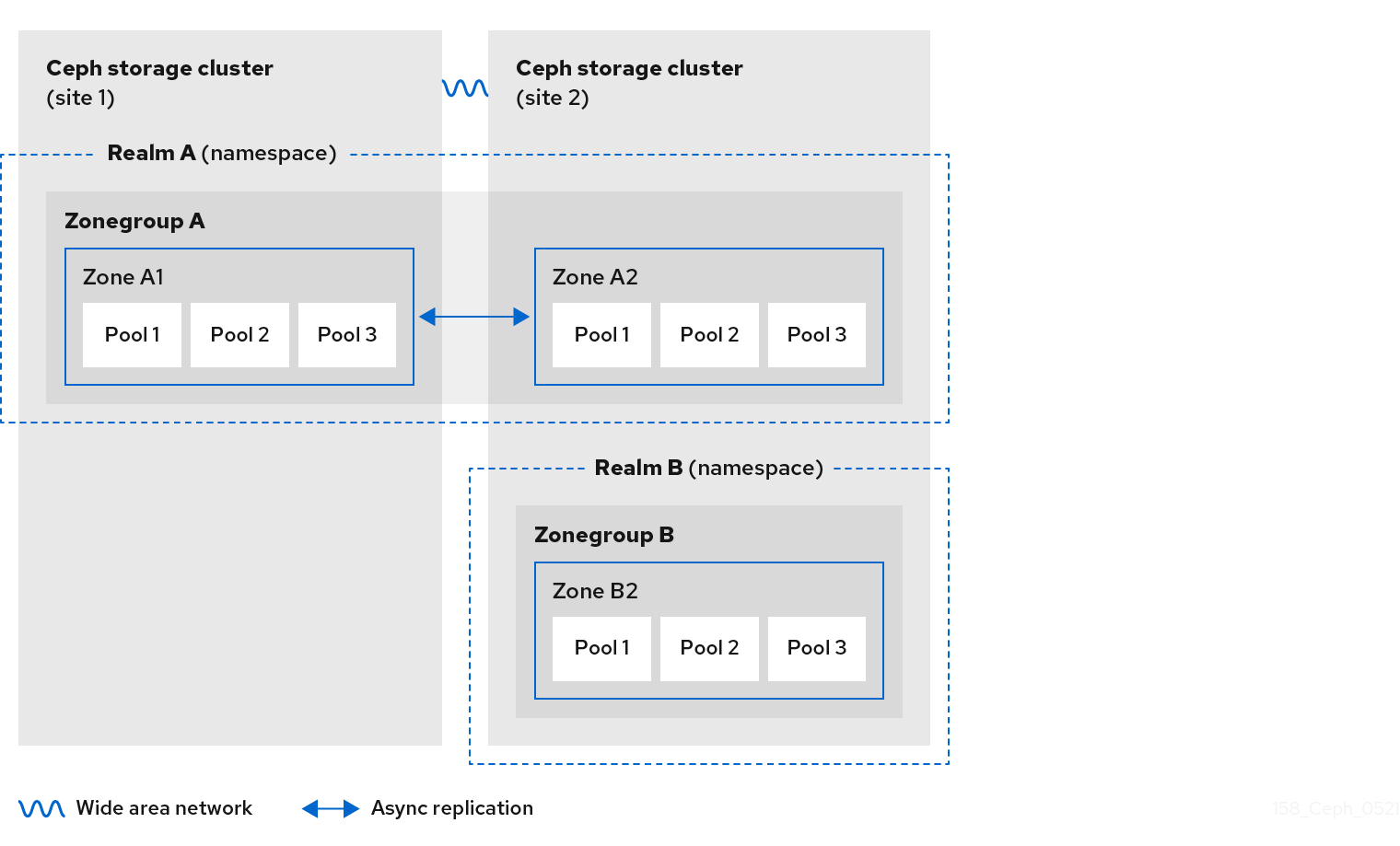

下图说明了在多站点 Ceph 对象网关环境中可能采用的一种和两个域配置。

图 2.4. 一个域

图 2.5. 两个 Realms

图 2.6. 两个 Realms Variant

2.8. 考虑存储大小

设计集群时最重要的因素之一是确定存储要求(大小)。Ceph 存储设计为可以扩展到 PB 以上。以下示例是 Ceph 存储集群的常见大小。

- Small: 250 TB

- Medium:1 Ptabyte

- 大型: 2 PB 或更多 PB

大小调整包括当前需求和近乎未来的需求。请考虑网关客户端向群集添加新数据的速率。这可能因用例而异。例如,录制 4k 视频或存储医疗图像与较低存储密集型信息(如金融市场数据)相比,会更快地添加大量数据。另外,请考虑数据持久性方法(如复制与擦除编码)可能会对所需的存储介质产生显著影响。

有关大小调整的更多信息,请参阅 Red Hat Ceph Storage Hardware Guide 及其相关链接,以选择 OSD 硬件。

2.9. 考虑存储密度

Ceph 设计的另一个重要方面,包括存储密度。通常,存储集群将数据存储在至少 10 个节点中,以确保在复制、回填和恢复时提供合理的性能。如果节点出现故障,存储集群中至少有 10 个节点,则只有 10% 的数据必须移动到存活的节点。如果节点数量大大减少,则必须将更高的数据百分比移到存活的节点。此外,还需要设置 full_ratio 和 near_full_ratio 选项,以适应节点故障,以确保存储集群可以写入数据。因此,务必要考虑存储密度。更高的存储密度不一定是一个不错的想法。

与更高的存储密度相比,另一个因素是纠删代码。当使用纠删代码编写对象并将 节点 用作最低 CRUSH 故障域时,Ceph 存储群集将需要尽可能多的节点,作为数据和编码区块。例如,使用 k=8, m=3 的集群应该至少有 11 个节点,每个数据或编码区块都存储在单独的节点上。

热插拔也是重要的考虑因素。大多数现代服务器都支持驱动器热插拔。但是,一些硬件配置需要删除多个驱动器来替换驱动器。红帽建议避免此类配置,因为它们可以在交换失败的磁盘时导致超过所需数量的 Ceph OSD。

2.10. 为 Ceph 监控节点考虑磁盘

Ceph 监控器使用 rocksdb,这对同步写入延迟非常敏感。红帽强烈建议使用 SSD 磁盘来存储 Ceph 监控数据。选择具有足够连续写入和吞吐量特征的 SSD 磁盘。

2.11. 调整回填和恢复设置

I/O 受到回填和恢复操作的负面影响,导致性能低下和最终用户不满意。要帮助满足集群扩展或恢复期间的 I/O 需求,请在 Ceph 配置文件中设置以下选项和值:

[osd] osd_max_backfills = 1 osd_recovery_max_active = 1 osd_recovery_op_priority = 1

[osd]

osd_max_backfills = 1

osd_recovery_max_active = 1

osd_recovery_op_priority = 12.12. 调整集群映射大小

默认情况下,ceph-osd 守护进程缓存以前的 500 个 osdmaps。即使使用重复数据删除,映射可能会在每个守护进程消耗大量内存。在 Ceph 配置中调优缓存大小有助于显著减少内存消耗。例如:

[ceph: root@host01 /]# ceph config set global osd_map_message_max 10 [ceph: root@host01 /]# ceph config set osd osd_map_cache_size 20 [ceph: root@host01 /]# ceph config set osd osd_map_share_max_epochs 10 [ceph: root@host01 /]# ceph config set osd osd_pg_epoch_persisted_max_stale 10

[ceph: root@host01 /]# ceph config set global osd_map_message_max 10

[ceph: root@host01 /]# ceph config set osd osd_map_cache_size 20

[ceph: root@host01 /]# ceph config set osd osd_map_share_max_epochs 10

[ceph: root@host01 /]# ceph config set osd osd_pg_epoch_persisted_max_stale 10

对于 Red Hat Ceph Storage 版本 3 及更高版本,ceph-manager 守护进程处理 PG 查询,因此 cluster map 不会影响性能。

2.13. 调整清理

默认情况下,Ceph 每周执行轻型清理和深度清理。轻型清理检查对象大小和校验和,以确保 PG 存储相同的对象数据。随着时间的推移,磁盘扇区的对象大小和校验和可能会变得不良。深度清理检查对象的副本内容,以确保实际内容相同。为此,深度清理以 fsck 的方式确保数据完整性,但该过程会对集群施加 I/O 罚款。甚至轻型清理也会影响 I/O。

默认设置可能允许 Ceph OSD 在不正常情况下启动清理,如高峰操作或负载过重的周期。当清理操作与最终用户操作冲突时,最终用户可能会遇到延迟和性能不佳的情况。

为了防止最终用户性能下降,Ceph 提供了多个清理设置,可将清理限制为负载较低或非高峰时段的期间。详情请参阅 Red Hat Ceph Storage 配置指南中的清理 OSD 部分。

如果集群在一天中出现高负载,当晚晚出现低负载时,请考虑将清理限制为夜间小时。例如:

[osd] osd_scrub_begin_hour = 23 #23:01H, or 10:01PM. osd_scrub_end_hour = 6 #06:01H or 6:01AM.

[osd]

osd_scrub_begin_hour = 23 #23:01H, or 10:01PM.

osd_scrub_end_hour = 6 #06:01H or 6:01AM.

如果时间限制不是确定清理计划的有效方法,请考虑使用 osd_scrub_load_threshold。默认值为 0.5,但可以根据低负载状况进行修改。例如:

[osd] osd_scrub_load_threshold = 0.25

[osd]

osd_scrub_load_threshold = 0.252.14. 增加 objecter_inflight_ops

为提高可伸缩性,您可以编辑 objecter_inflight_ops 参数的值,该参数指定了允许的最大未识别 I/O 请求的数量。这个参数用于客户端流量控制。

objecter_inflight_ops = 24576

objecter_inflight_ops = 245762.15. 提高 rgw_thread_pool_size

要提高可伸缩性,您可以编辑 rgw_thread_pool_size 参数的值,这是线程池的大小。新的 beast frontend 不受线程池大小限制,以接受新连接。

rgw_thread_pool_size = 512

rgw_thread_pool_size = 5122.16. 在运行 Ceph 时调整 Linux 内核的注意事项

生产环境的 Red Hat Ceph Storage 集群通常受益于操作系统调优,尤其是关于限值和内存分配。确保为存储集群中的所有主机进行了调整。您还可以在红帽支持下创建一个问题单,寻求其他指导。

增加文件描述符数量

如果 Ceph 对象网关缺少文件描述符,它可能会挂起。您可以修改 Ceph 对象网关主机上的 /etc/security/limits.conf 文件,以增加 Ceph 对象网关的文件描述符。

ceph soft nofile unlimited

ceph soft nofile unlimited调整大型存储集群的 ulimit 值

在大型存储集群上运行 Ceph 管理命令时, 例如,带有 1024 个 Ceph OSD 或更多 OSD, 在每个运行管理命令的主机上创建一个 /etc/security/limits.d/50-ceph.conf 文件,其中包含以下内容:

USER_NAME soft nproc unlimited

USER_NAME soft nproc unlimited将 USER_NAME 替换为运行 Ceph 管理命令的非 root 用户帐户的名称。

在 Red Hat Enterprise Linux 中,root 用户的 ulimit 值默认设置为 ulimit。

第 3 章 Deployment

作为存储管理员,您可以通过命令行界面或服务规格,使用 Ceph Orchestrator 部署 Ceph 对象网关。您也可以配置多站点 Ceph 对象网关,并使用 Ceph 编排器删除 Ceph 对象网关。

cephadm 命令将 Ceph 对象网关部署为守护进程集合,这些守护进程在多站点部署中管理单集群部署或特定的域和区域。

使用 cephadm 时,Ceph 对象网关守护进程配置为使用 Ceph monitor 配置数据库,而不是 ceph.conf 文件或命令行选项。如果配置不在 client.rgw 部分中,则 Ceph 对象网关守护进程从默认设置启动,并绑定到端口 80。

如果您希望 Cephadm 处理 realm 和 zone 的设置,请在部署 Ceph 对象网关期间在服务规格中指定 realm 和 zone。如果要在以后更改该 realm 或 zone,请确保更新并重新应用规格文件中的 rgw_realm 和 rgw_zone 参数。

如果要在没有 Cephadm 的情况下手动处理这些选项,请不要将它们包含在服务规格中。Cephadm 仍然部署 Ceph 对象网关守护进程,而不设置守护进程应使用的域或区域。在这种情况下,规范文件的更新不必要。

本节涵盖了以下管理任务:

3.1. 先决条件

- 一个运行良好、健康的 Red Hat Ceph Storage 集群。

- 所有节点的根级别访问权限。

- 存储集群上的可用节点。

- 所有管理器、监视器和 OSD 都部署在存储集群中。

3.2. 使用命令行界面部署 Ceph 对象网关

利用 Ceph 编排器,您可以在命令行界面中使用 ceph 或ch 命令部署 Ceph 对象网关。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 所有节点的根级别访问权限。

- 主机添加到集群中。

- 部署所有管理器、监控器和 OSD 守护进程。

流程

登录到 Cephadm shell:

示例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 您可以通过三种不同的方式部署 Ceph 对象网关守护进程:

方法 1

创建 realm、zone group、zone,然后使用放置规格与主机名:

创建一个域:

语法

radosgw-admin realm create --rgw-realm=REALM_NAME --default

radosgw-admin realm create --rgw-realm=REALM_NAME --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# radosgw-admin realm create --rgw-realm=test_realm --default

[ceph: root@host01 /]# radosgw-admin realm create --rgw-realm=test_realm --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建区组:

语法

radosgw-admin zonegroup create --rgw-zonegroup=ZONE_GROUP_NAME --master --default

radosgw-admin zonegroup create --rgw-zonegroup=ZONE_GROUP_NAME --master --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# radosgw-admin zonegroup create --rgw-zonegroup=default --master --default

[ceph: root@host01 /]# radosgw-admin zonegroup create --rgw-zonegroup=default --master --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建区:

语法

radosgw-admin zone create --rgw-zonegroup=ZONE_GROUP_NAME --rgw-zone=ZONE_NAME --master --default

radosgw-admin zone create --rgw-zonegroup=ZONE_GROUP_NAME --rgw-zone=ZONE_NAME --master --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# radosgw-admin zone create --rgw-zonegroup=default --rgw-zone=test_zone --master --default

[ceph: root@host01 /]# radosgw-admin zone create --rgw-zonegroup=default --rgw-zone=test_zone --master --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 提交更改:

语法

radosgw-admin period update --rgw-realm=REALM_NAME --commit

radosgw-admin period update --rgw-realm=REALM_NAME --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# radosgw-admin period update --rgw-realm=test_realm --commit

[ceph: root@host01 /]# radosgw-admin period update --rgw-realm=test_realm --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行

ceph orch apply命令:语法

ceph orch apply rgw NAME [--realm=REALM_NAME] [--zone=ZONE_NAME] --placement="NUMBER_OF_DAEMONS [HOST_NAME_1 HOST_NAME_2]"

ceph orch apply rgw NAME [--realm=REALM_NAME] [--zone=ZONE_NAME] --placement="NUMBER_OF_DAEMONS [HOST_NAME_1 HOST_NAME_2]"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph orch apply rgw test --realm=test_realm --zone=test_zone --placement="2 host01 host02"

[ceph: root@host01 /]# ceph orch apply rgw test --realm=test_realm --zone=test_zone --placement="2 host01 host02"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

方法 2

使用任意服务名称为单个集群部署部署两个 Ceph 对象网关守护进程:

语法

ceph orch apply rgw SERVICE_NAME

ceph orch apply rgw SERVICE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph orch apply rgw foo

[ceph: root@host01 /]# ceph orch apply rgw fooCopy to Clipboard Copied! Toggle word wrap Toggle overflow

方法 3

在标记的一组主机上使用任意服务名称:

语法

ceph orch host label add HOST_NAME_1 LABEL_NAME ceph orch host label add HOSTNAME_2 LABEL_NAME ceph orch apply rgw SERVICE_NAME --placement="label:LABEL_NAME count-per-host:NUMBER_OF_DAEMONS" --port=8000

ceph orch host label add HOST_NAME_1 LABEL_NAME ceph orch host label add HOSTNAME_2 LABEL_NAME ceph orch apply rgw SERVICE_NAME --placement="label:LABEL_NAME count-per-host:NUMBER_OF_DAEMONS" --port=8000Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意NUMBER_OF_DAEMONS 控制每个主机上部署的 Ceph 对象网关数量。要在不产生额外成本的情况下获得最高性能,请将此值设置为 2。

示例

[ceph: root@host01 /]# ceph orch host label add host01 rgw # the 'rgw' label can be anything [ceph: root@host01 /]# ceph orch host label add host02 rgw [ceph: root@host01 /]# ceph orch apply rgw foo --placement="2 label:rgw" --port=8000

[ceph: root@host01 /]# ceph orch host label add host01 rgw # the 'rgw' label can be anything [ceph: root@host01 /]# ceph orch host label add host02 rgw [ceph: root@host01 /]# ceph orch apply rgw foo --placement="2 label:rgw" --port=8000Copy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

列出服务:

示例

[ceph: root@host01 /]# ceph orch ls

[ceph: root@host01 /]# ceph orch lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 列出主机、守护进程和进程:

语法

ceph orch ps --daemon_type=DAEMON_NAME

ceph orch ps --daemon_type=DAEMON_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph orch ps --daemon_type=rgw

[ceph: root@host01 /]# ceph orch ps --daemon_type=rgwCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3. 使用服务规格部署 Ceph 对象网关

您可以使用服务规格(带有 default 或 custom realms、zone 和 zone group)部署 Ceph 对象网关。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 对 bootstrap 启动主机的 root 级别访问权限。

- 主机添加到集群中。

- 部署所有管理器、监控和 OSD 守护进程。

流程

作为 root 用户,创建一个规格文件:

示例

touch radosgw.yml

[root@host01 ~]# touch radosgw.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 编辑

radosgw.yml文件,使其包含 default realm、zone 和 zone group 的以下详情:语法

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意NUMBER_OF_DAEMONS 控制每个主机上部署的 Ceph 对象网关数量。要在不产生额外成本的情况下获得最高性能,请将此值设置为 2。

示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 可选: 对于自定义 realm、zone 和 zone group,创建资源,然后创建

radosgw.yml文件:创建自定义域、区和 zone 组:

示例

radosgw-admin realm create --rgw-realm=test_realm --default radosgw-admin zonegroup create --rgw-zonegroup=test_zonegroup --default radosgw-admin zone create --rgw-zonegroup=test_zonegroup --rgw-zone=test_zone --default radosgw-admin period update --rgw-realm=test_realm --commit

[root@host01 ~]# radosgw-admin realm create --rgw-realm=test_realm --default [root@host01 ~]# radosgw-admin zonegroup create --rgw-zonegroup=test_zonegroup --default [root@host01 ~]# radosgw-admin zone create --rgw-zonegroup=test_zonegroup --rgw-zone=test_zone --default [root@host01 ~]# radosgw-admin period update --rgw-realm=test_realm --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用以下详细信息,创建

radosgw.yml文件:示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

将

radosgw.yml文件挂载到容器中的某个目录下:示例

cephadm shell --mount radosgw.yml:/var/lib/ceph/radosgw/radosgw.yml

[root@host01 ~]# cephadm shell --mount radosgw.yml:/var/lib/ceph/radosgw/radosgw.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意每次退出 shell 时,您必须先将该文件挂载到容器中,然后才能部署守护进程。

使用服务规格部署 Ceph 对象网关:

语法

ceph orch apply -i FILE_NAME.yml

ceph orch apply -i FILE_NAME.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph orch apply -i radosgw.yml

[ceph: root@host01 /]# ceph orch apply -i radosgw.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

列出服务:

示例

[ceph: root@host01 /]# ceph orch ls

[ceph: root@host01 /]# ceph orch lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 列出主机、守护进程和进程:

语法

ceph orch ps --daemon_type=DAEMON_NAME

ceph orch ps --daemon_type=DAEMON_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph orch ps --daemon_type=rgw

[ceph: root@host01 /]# ceph orch ps --daemon_type=rgwCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4. 使用 Ceph 编排器部署多站点 Ceph 对象网关

Ceph 编排器支持 Ceph 对象网关的多站点配置选项。

您可以将每个对象网关配置为在主动区配置中工作,从而允许写入非主区。多站点配置存储在名为 realm 的容器中。

realm 存储 zone group、zone 和 时间段。rgw 守护进程处理同步消除了对独立同步代理的需求,因此使用主动-主动配置运行。

您还可以使用命令行界面(CLI)部署多站点区域。

以下配置假定在地理上至少有两个 Red Hat Ceph Storage 集群。但是,配置也在同一站点工作。

先决条件

- 至少两个正在运行的 Red Hat Ceph Storage 集群。

- 至少两个 Ceph 对象网关实例,每个实例对应一个 Red Hat Ceph Storage 集群。

- 所有节点的根级别访问权限。

- 节点或容器添加到存储集群中。

- 部署所有 Ceph 管理器、监控器和 OSD 守护进程。

流程

在

cephadmshell 中,配置主区:创建一个域:

语法

radosgw-admin realm create --rgw-realm=REALM_NAME --default

radosgw-admin realm create --rgw-realm=REALM_NAME --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# radosgw-admin realm create --rgw-realm=test_realm --default

[ceph: root@host01 /]# radosgw-admin realm create --rgw-realm=test_realm --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果存储集群只有一个域,则指定

--default标志。创建主要区组:

语法

radosgw-admin zonegroup create --rgw-zonegroup=ZONE_GROUP_NAME --endpoints=http://RGW_PRIMARY_HOSTNAME:RGW_PRIMARY_PORT_NUMBER_1 --master --default

radosgw-admin zonegroup create --rgw-zonegroup=ZONE_GROUP_NAME --endpoints=http://RGW_PRIMARY_HOSTNAME:RGW_PRIMARY_PORT_NUMBER_1 --master --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# radosgw-admin zonegroup create --rgw-zonegroup=us --endpoints=http://rgw1:80 --master --default

[ceph: root@host01 /]# radosgw-admin zonegroup create --rgw-zonegroup=us --endpoints=http://rgw1:80 --master --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建一个主要区:

语法

radosgw-admin zone create --rgw-zonegroup=PRIMARY_ZONE_GROUP_NAME --rgw-zone=PRIMARY_ZONE_NAME --endpoints=http://RGW_PRIMARY_HOSTNAME:RGW_PRIMARY_PORT_NUMBER_1 --access-key=SYSTEM_ACCESS_KEY --secret=SYSTEM_SECRET_KEY

radosgw-admin zone create --rgw-zonegroup=PRIMARY_ZONE_GROUP_NAME --rgw-zone=PRIMARY_ZONE_NAME --endpoints=http://RGW_PRIMARY_HOSTNAME:RGW_PRIMARY_PORT_NUMBER_1 --access-key=SYSTEM_ACCESS_KEY --secret=SYSTEM_SECRET_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# radosgw-admin zone create --rgw-zonegroup=us --rgw-zone=us-east-1 --endpoints=http://rgw1:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQ

[ceph: root@host01 /]# radosgw-admin zone create --rgw-zonegroup=us --rgw-zone=us-east-1 --endpoints=http://rgw1:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQCopy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:删除默认 zone、zone group 和关联的池。

重要如果您使用默认 zone 和 zone group 存储数据,则不要删除默认区域及其池。另外,删除默认 zone group 会删除系统用户。

要访问

defaultzone 和 zonegroup 中的旧数据,请在radosgw-admin命令中使用--rgw-zone default和--rgw-zonegroup default。示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建系统用户:

语法

radosgw-admin user create --uid=USER_NAME --display-name="USER_NAME" --access-key=SYSTEM_ACCESS_KEY --secret=SYSTEM_SECRET_KEY --system

radosgw-admin user create --uid=USER_NAME --display-name="USER_NAME" --access-key=SYSTEM_ACCESS_KEY --secret=SYSTEM_SECRET_KEY --systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# radosgw-admin user create --uid=zone.user --display-name="Zone user" --system

[ceph: root@host01 /]# radosgw-admin user create --uid=zone.user --display-name="Zone user" --systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 记录

access_key和secret_key。在主区中添加 access key 和 system key:

语法

radosgw-admin zone modify --rgw-zone=PRIMARY_ZONE_NAME --access-key=ACCESS_KEY --secret=SECRET_KEY

radosgw-admin zone modify --rgw-zone=PRIMARY_ZONE_NAME --access-key=ACCESS_KEY --secret=SECRET_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# radosgw-admin zone modify --rgw-zone=us-east-1 --access-key=NE48APYCAODEPLKBCZVQ --secret=u24GHQWRE3yxxNBnFBzjM4jn14mFIckQ4EKL6LoW

[ceph: root@host01 /]# radosgw-admin zone modify --rgw-zone=us-east-1 --access-key=NE48APYCAODEPLKBCZVQ --secret=u24GHQWRE3yxxNBnFBzjM4jn14mFIckQ4EKL6LoWCopy to Clipboard Copied! Toggle word wrap Toggle overflow 提交更改:

语法

radosgw-admin period update --commit

radosgw-admin period update --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# radosgw-admin period update --commit

[ceph: root@host01 /]# radosgw-admin period update --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

cephadmshell 外部,获取存储集群的FSID及进程:示例

systemctl list-units | grep ceph

[root@host01 ~]# systemctl list-units | grep cephCopy to Clipboard Copied! Toggle word wrap Toggle overflow 启动 Ceph 对象网关守护进程:

语法

systemctl start ceph-FSID@DAEMON_NAME systemctl enable ceph-FSID@DAEMON_NAME

systemctl start ceph-FSID@DAEMON_NAME systemctl enable ceph-FSID@DAEMON_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

systemctl start ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-1.host01.ahdtsw.service systemctl enable ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-1.host01.ahdtsw.service

[root@host01 ~]# systemctl start ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-1.host01.ahdtsw.service [root@host01 ~]# systemctl enable ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-1.host01.ahdtsw.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

在 Cephadm shell 中,配置 second zone。

从主机拉取主要域配置:

语法

radosgw-admin realm pull --rgw-realm=PRIMARY_REALM --url=URL_TO_PRIMARY_ZONE_GATEWAY --access-key=ACCESS_KEY --secret-key=SECRET_KEY --default

radosgw-admin realm pull --rgw-realm=PRIMARY_REALM --url=URL_TO_PRIMARY_ZONE_GATEWAY --access-key=ACCESS_KEY --secret-key=SECRET_KEY --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host04 /]# radosgw-admin realm pull --rgw-realm=test_realm --url=http://10.74.249.26:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQ --default

[ceph: root@host04 /]# radosgw-admin realm pull --rgw-realm=test_realm --url=http://10.74.249.26:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQ --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 从主机拉取主要 period 配置:

语法

radosgw-admin period pull --url=URL_TO_PRIMARY_ZONE_GATEWAY --access-key=ACCESS_KEY --secret-key=SECRET_KEY

radosgw-admin period pull --url=URL_TO_PRIMARY_ZONE_GATEWAY --access-key=ACCESS_KEY --secret-key=SECRET_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host04 /]# radosgw-admin period pull --url=http://10.74.249.26:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQ

[ceph: root@host04 /]# radosgw-admin period pull --url=http://10.74.249.26:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQCopy to Clipboard Copied! Toggle word wrap Toggle overflow 配置 second zone:

语法

radosgw-admin zone create --rgw-zonegroup=ZONE_GROUP_NAME \ --rgw-zone=SECONDARY_ZONE_NAME --endpoints=http://RGW_SECONDARY_HOSTNAME:RGW_PRIMARY_PORT_NUMBER_1 \ --access-key=SYSTEM_ACCESS_KEY --secret=SYSTEM_SECRET_KEY \ --endpoints=http://FQDN:80 \ [--read-only]radosgw-admin zone create --rgw-zonegroup=ZONE_GROUP_NAME \ --rgw-zone=SECONDARY_ZONE_NAME --endpoints=http://RGW_SECONDARY_HOSTNAME:RGW_PRIMARY_PORT_NUMBER_1 \ --access-key=SYSTEM_ACCESS_KEY --secret=SYSTEM_SECRET_KEY \ --endpoints=http://FQDN:80 \ [--read-only]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host04 /]# radosgw-admin zone create --rgw-zonegroup=us --rgw-zone=us-east-2 --endpoints=http://rgw2:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQ

[ceph: root@host04 /]# radosgw-admin zone create --rgw-zonegroup=us --rgw-zone=us-east-2 --endpoints=http://rgw2:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQCopy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:删除默认区。

重要如果您使用默认 zone 和 zone group 存储数据,则不要删除默认区域及其池。

要访问

defaultzone 和 zonegroup 中的旧数据,请在radosgw-admin命令中使用--rgw-zone default和--rgw-zonegroup default。示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 更新 Ceph 配置数据库:

语法

ceph config set SERVICE_NAME rgw_zone SECONDARY_ZONE_NAME

ceph config set SERVICE_NAME rgw_zone SECONDARY_ZONE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host04 /]# ceph config set rgw rgw_zone us-east-2

[ceph: root@host04 /]# ceph config set rgw rgw_zone us-east-2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 提交更改:

语法

radosgw-admin period update --commit

radosgw-admin period update --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host04 /]# radosgw-admin period update --commit

[ceph: root@host04 /]# radosgw-admin period update --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在 Cephadm shell 外,获取存储集群的 FSID 及进程:

示例

systemctl list-units | grep ceph

[root@host04 ~]# systemctl list-units | grep cephCopy to Clipboard Copied! Toggle word wrap Toggle overflow 启动 Ceph 对象网关守护进程:

语法

systemctl start ceph-FSID@DAEMON_NAME systemctl enable ceph-FSID@DAEMON_NAME

systemctl start ceph-FSID@DAEMON_NAME systemctl enable ceph-FSID@DAEMON_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

systemctl start ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-2.host04.ahdtsw.service systemctl enable ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-2.host04.ahdtsw.service

[root@host04 ~]# systemctl start ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-2.host04.ahdtsw.service [root@host04 ~]# systemctl enable ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-2.host04.ahdtsw.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

可选:使用放置规格部署多站点 Ceph 对象网关:

语法

ceph orch apply rgw NAME --realm=REALM_NAME --zone=PRIMARY_ZONE_NAME --placement="NUMBER_OF_DAEMONS HOST_NAME_1 HOST_NAME_2"

ceph orch apply rgw NAME --realm=REALM_NAME --zone=PRIMARY_ZONE_NAME --placement="NUMBER_OF_DAEMONS HOST_NAME_1 HOST_NAME_2"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host04 /]# ceph orch apply rgw east --realm=test_realm --zone=us-east-1 --placement="2 host01 host02"

[ceph: root@host04 /]# ceph orch apply rgw east --realm=test_realm --zone=us-east-1 --placement="2 host01 host02"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

检查同步状态以验证部署:

示例

[ceph: root@host04 /]# radosgw-admin sync status

[ceph: root@host04 /]# radosgw-admin sync statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5. 使用 Ceph 编排器移除 Ceph 对象网关

您可以使用 ceph orch rm 命令移除 Ceph 对象网关守护进程。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 所有节点的根级别访问权限。

- 主机添加到集群中。

- 主机上至少部署了一个 Ceph 对象网关守护进程。

流程

登录到 Cephadm shell:

示例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow 列出服务:

示例

[ceph: root@host01 /]# ceph orch ls

[ceph: root@host01 /]# ceph orch lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 删除服务:

语法

ceph orch rm SERVICE_NAME

ceph orch rm SERVICE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph orch rm rgw.test_realm.test_zone_bb

[ceph: root@host01 /]# ceph orch rm rgw.test_realm.test_zone_bbCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

列出主机、守护进程和进程:

语法

ceph orch ps

ceph orch psCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph orch ps

[ceph: root@host01 /]# ceph orch psCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 4 章 基本配置

作为存储管理员,了解配置 Ceph 对象网关的基础知识非常重要。您可以了解默认设置和名为 Beast 嵌入的 Web 服务器。若要对 Ceph 对象网关问题进行故障排除,您可以调整 Ceph 对象网关生成的日志记录和调试输出。另外,您还可使用 Ceph 对象网关为存储集群访问提供高可用性代理。

4.1. 先决条件

- 一个运行良好、健康的 Red Hat Ceph Storage 集群。

- 安装 Ceph 对象网关软件包.

4.2. 在 DNS 中添加通配符

您可以将通配符(如 hostname)添加到 DNS 服务器的 DNS 记录中。

前提条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 安装了 Ceph 对象网关.

- 对管理节点的根级别访问权限。

流程

要将 Ceph 与 S3-style 子域一起使用,请向

ceph-ResourceOverride 守护进程用来解析域名的 DNS 服务器的 DNS 记录中添加通配符:语法

bucket-name.domain-name.com

bucket-name.domain-name.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 对于

dnsmasq,使用主机名前的句点(.)添加以下地址设置:语法

address=/.HOSTNAME_OR_FQDN/HOST_IP_ADDRESS

address=/.HOSTNAME_OR_FQDN/HOST_IP_ADDRESSCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

address=/.gateway-host01/192.168.122.75

address=/.gateway-host01/192.168.122.75Copy to Clipboard Copied! Toggle word wrap Toggle overflow 对于

bind,在 DNS 记录中添加通配符:示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重启 DNS 服务器并使用子域对服务器发出 ping 命令,以确保

ceph-radosgw守护进程可以处理子域请求:语法

ping mybucket.HOSTNAME

ping mybucket.HOSTNAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

ping mybucket.gateway-host01

[root@host01 ~]# ping mybucket.gateway-host01Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

如果 DNS 服务器位于本地机器上,则可能需要通过为本地机器添加 nameserver 条目来修改

/etc/resolv.conf。 在 Ceph 对象网关 zone group 中添加主机名:

获取 zone group:

语法

radosgw-admin zonegroup get --rgw-zonegroup=ZONEGROUP_NAME > zonegroup.json

radosgw-admin zonegroup get --rgw-zonegroup=ZONEGROUP_NAME > zonegroup.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# radosgw-admin zonegroup get --rgw-zonegroup=us > zonegroup.json

[ceph: root@host01 /]# radosgw-admin zonegroup get --rgw-zonegroup=us > zonegroup.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用 JSON 文件备份:

示例

[ceph: root@host01 /]# cp zonegroup.json zonegroup.backup.json

[ceph: root@host01 /]# cp zonegroup.json zonegroup.backup.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 查看

zonegroup.json文件:示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用新主机名更新

zonegroup.json文件:示例

"hostnames": ["host01", "host02","host03"],

"hostnames": ["host01", "host02","host03"],Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在 Ceph 对象网关中设置 zone group back:

语法

radosgw-admin zonegroup set --rgw-zonegroup=ZONEGROUP_NAME --infile=zonegroup.json

radosgw-admin zonegroup set --rgw-zonegroup=ZONEGROUP_NAME --infile=zonegroup.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# radosgw-admin zonegroup set --rgw-zonegroup=us --infile=zonegroup.json

[ceph: root@host01 /]# radosgw-admin zonegroup set --rgw-zonegroup=us --infile=zonegroup.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 更新周期:

示例

[ceph: root@host01 /]# radosgw-admin period update --commit

[ceph: root@host01 /]# radosgw-admin period update --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 重启 Ceph 对象网关,以便 DNS 设置生效。

4.3. Beast 前端 web 服务器

Ceph 对象网关提供 Beast,即 C/C 嵌入式前端 Web 服务器。BEAST 使用 'Boost.Beast' C 库来解析 HTTP,Bost .Asio 用于异步网络 I/O。

4.4. 为 Beast 配置 SSL

您可以将 Beast 前端 web 服务器配置为使用 OpenSSL 库来提供传输层安全性(TLS)。若要将安全套接字层(SSL)与 Beast 搭配使用,您需要从与 Ceph 对象网关节点的主机名匹配的证书颁发机构(CA)获取证书。Beast 还需要 secret 密钥、服务器证书以及 single .pem 文件中的任何其他 CA。

防止未经授权访问 .pem 文件,因为它包含 secret 密钥哈希。

红帽建议从带有 Subject Alternative Name(SAN)字段的 CA 获取证书,以及用于 S3 样式子域的通配符。

红帽建议仅将 SSL 与 Beast 前端 Web 服务器用于中小型测试环境。对于生产环境,您必须使用 HAProxy 和 keepalived 来终止 HAProxy 中的 SSL 连接。

如果 Ceph 对象网关充当客户端和自定义证书,您可以在节点上导入自定义 CA,然后将 etc/pki 目录映射到容器,使用 Ceph 对象网关规格文件中的 extra_container_args 参数将它注入容器。

先决条件

- 一个运行良好、健康的 Red Hat Ceph Storage 集群。

- 安装 Ceph 对象网关软件包.

- 安装 OpenSSL 软件包.

- Ceph 对象网关节点的根级别访问权限.

流程

在当前目录中创建一个名为

rgw.yml的新文件:示例

[ceph: root@host01 /]# touch rgw.yml

[ceph: root@host01 /]# touch rgw.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 打开

rgw.yml文件进行编辑,并根据环境自定义该文件:语法

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用服务规格文件部署 Ceph 对象网关:

示例

[ceph: root@host01 /]# ceph orch apply -i rgw.yml

[ceph: root@host01 /]# ceph orch apply -i rgw.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5. 调整日志记录和调试输出

完成设置过程后,检查日志输出以确保它满足您的需要。默认情况下,Ceph 守护进程日志到 journald,您可以使用 journalctl 命令查看日志。或者,您也可以将 Ceph 守护进程日志指向文件,这些文件位于 /var/log/ceph/CEPH_CLUSTER_ID/ 目录下。

详细日志记录每小时可生成超过 1 GB 数据。这种类型的日志记录可能会填满操作系统的磁盘,从而导致操作系统停止正常运行。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 安装 Ceph 对象网关软件.

流程

设置以下参数以增加 Ceph 对象网关日志输出:

语法

ceph config set client.rgw debug_rgw VALUE

ceph config set client.rgw debug_rgw VALUECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph config set client.rgw debug_rgw 20

[ceph: root@host01 /]# ceph config set client.rgw debug_rgw 20Copy to Clipboard Copied! Toggle word wrap Toggle overflow 您还可以在运行时修改这些设置:

语法

ceph --admin-daemon /var/run/ceph/ceph-client.rgw.NAME.asok config set debug_rgw VALUE

ceph --admin-daemon /var/run/ceph/ceph-client.rgw.NAME.asok config set debug_rgw VALUECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph --admin-daemon /var/run/ceph/ceph-client.rgw.rgw.asok config set debug_rgw 20

[ceph: root@host01 /]# ceph --admin-daemon /var/run/ceph/ceph-client.rgw.rgw.asok config set debug_rgw 20Copy to Clipboard Copied! Toggle word wrap Toggle overflow

(可选)您可以将 Ceph 守护进程配置为将其输出记录到文件中。将

log_to_file和mon_cluster_log_to_file选项设置为true:示例

[ceph: root@host01 /]# ceph config set global log_to_file true [ceph: root@host01 /]# ceph config set global mon_cluster_log_to_file true

[ceph: root@host01 /]# ceph config set global log_to_file true [ceph: root@host01 /]# ceph config set global mon_cluster_log_to_file trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.6. 静态 Web 托管

作为存储管理员,您可以将 Ceph 对象网关配置为托管 S3 存储桶中的静态网站。传统网站托管涉及为各个网站配置 Web 服务器,当内容未动态更改时,此服务器会以低效的方式使用资源。例如,站点不使用 PHP、servlets、database、nodejs 等服务器端服务。这种方法比设置具有每个站点 Web 服务器的虚拟机更经济。

4.6.1. 先决条件

- 一个正常运行的 Red Hat Ceph Storage 集群。

4.6.2. 静态 Web 托管假设

静态 Web 托管至少需要一个运行 Red Hat Ceph Storage 集群,以及至少两个用于静态网站的 Ceph 对象网关实例。红帽假定每个区域都将具有多个使用负载平衡器的网关实例,如高可用性(HA)代理和 keepalived。

红帽 不支持 使用 Ceph 对象网关实例来同时部署标准 S3/Swift API 和静态 Web 主机。

4.6.3. 静态 Web 托管要求

静态 Web 托管功能使用自己的 API,因此将网关配置为在 S3 存储桶中使用静态网站需要以下内容:

- S3 静态 Web 托管使用 Ceph 对象网关实例,这些实例与用于标准 S3/Swift API 用例的实例不同。

- 托管 S3 静态网站的网关实例应具有独立于标准 S3/Swift API 网关实例的单独、非覆盖域名。

- 托管 S3 静态网站的网关实例应使用与标准 S3/Swift API 网关实例独立的面向公共的 IP 地址。

- 托管 S3 静态 web 站点负载均衡的网关实例,如有必要,使用 HAProxy/keepalived 终止 SSL。

4.6.4. 静态 Web 托管网关设置

要为静态 Web 托管启用 Ceph 对象网关,请设置以下选项:

语法

ceph config set client.rgw OPTION VALUE

ceph config set client.rgw OPTION VALUE示例

[ceph: root@host01 /]# ceph config set client.rgw rgw_enable_static_website true [ceph: root@host01 /]# ceph config set client.rgw rgw_enable_apis s3,s3website [ceph: root@host01 /]# ceph config set client.rgw rgw_dns_name objects-zonegroup.example.com [ceph: root@host01 /]# ceph config set client.rgw rgw_dns_s3website_name objects-website-zonegroup.example.com [ceph: root@host01 /]# ceph config set client.rgw rgw_resolve_cname true

[ceph: root@host01 /]# ceph config set client.rgw rgw_enable_static_website true

[ceph: root@host01 /]# ceph config set client.rgw rgw_enable_apis s3,s3website

[ceph: root@host01 /]# ceph config set client.rgw rgw_dns_name objects-zonegroup.example.com

[ceph: root@host01 /]# ceph config set client.rgw rgw_dns_s3website_name objects-website-zonegroup.example.com

[ceph: root@host01 /]# ceph config set client.rgw rgw_resolve_cname true

rgw_enable_static_website 设置需要为 true。rgw_enable_apis 设置需要启用 s3website API。rgw_dns_name 和 rgw_dns_s3website_name 设置必须提供其完全限定的域。如果站点使用规范名称扩展,则将 rgw_resolve_cname 选项设置为 true。

rgw_dns_name 和 rgw_dns_s3website_name 的 FQDN 不能 重叠。

4.6.5. 静态 Web 托管 DNS 配置

以下是假定的 DNS 设置示例,其中前两行使用标准 S3 接口指定网关实例的域,并指向 IPv4 和 IPv6 地址。第三行使用规范名称扩展为 S3 存储桶提供通配符 CNAME 设置。第四和第五行使用 S3 网站接口为网关实例指定域,并指向其 IPv4 和 IPv6 地址。

objects-zonegroup.domain.com. IN A 192.0.2.10 objects-zonegroup.domain.com. IN AAAA 2001:DB8::192:0:2:10 *.objects-zonegroup.domain.com. IN CNAME objects-zonegroup.domain.com. objects-website-zonegroup.domain.com. IN A 192.0.2.20 objects-website-zonegroup.domain.com. IN AAAA 2001:DB8::192:0:2:20

objects-zonegroup.domain.com. IN A 192.0.2.10

objects-zonegroup.domain.com. IN AAAA 2001:DB8::192:0:2:10

*.objects-zonegroup.domain.com. IN CNAME objects-zonegroup.domain.com.

objects-website-zonegroup.domain.com. IN A 192.0.2.20

objects-website-zonegroup.domain.com. IN AAAA 2001:DB8::192:0:2:20前两行中的 IP 地址与第四和第五个行中的 IP 地址有所不同。

如果在多站点配置中使用 Ceph 对象网关,请考虑使用路由解决方案将流量路由到最接近客户端的网关。

Amazon Web Service(AWS)需要静态 Web 主机存储桶才能与主机名匹配。Ceph 提供了几种不同的配置 DNS 的方式,如果代理具有匹配的证书,HTTPS 将正常工作。

Subdomain 中 Bucket 的主机名

要使用 AWS 风格的 S3 子域,在 DNS 条目中使用通配符,可以将请求重定向到任何存储桶。DNS 条目可能类似如下:

*.objects-website-zonegroup.domain.com. IN CNAME objects-website-zonegroup.domain.com.

*.objects-website-zonegroup.domain.com. IN CNAME objects-website-zonegroup.domain.com.

访问存储桶名为 bucket1 的存储桶名称,其方式如下:

http://bucket1.objects-website-zonegroup.domain.com

http://bucket1.objects-website-zonegroup.domain.com主机名到非匹配问题

Ceph 支持将域名映射到 bucket,而不在请求中包含 bucket 名称,这对 Ceph 对象网关而言是唯一的。要使用域名访问 bucket,请将域名映射到 bucket 名称。DNS 条目可能类似如下:

www.example.com. IN CNAME bucket2.objects-website-zonegroup.domain.com.

www.example.com. IN CNAME bucket2.objects-website-zonegroup.domain.com.

存储桶名称为 bucket2。

使用以下方法访问存储桶:

http://www.example.com

http://www.example.com使用 CNAME 到 Long Bucket 的主机名

AWS 通常需要存储桶名称来匹配域名。要使用 CNAME 为静态 Web 托管配置 DNS,DNS 条目可能类似如下:

www.example.com. IN CNAME www.example.com.objects-website-zonegroup.domain.com.

www.example.com. IN CNAME www.example.com.objects-website-zonegroup.domain.com.使用以下方法访问存储桶:

http://www.example.com

http://www.example.com没有 CNAME 的 Long Bucket 的主机名

如果 DNS 名称包含其他非CNAME 记录,如 SOA、NS NS、MX 或 TXT,DNS 记录必须直接将域名映射到 IP 地址。例如:

www.example.com. IN A 192.0.2.20 www.example.com. IN AAAA 2001:DB8::192:0:2:20

www.example.com. IN A 192.0.2.20

www.example.com. IN AAAA 2001:DB8::192:0:2:20使用以下方法访问存储桶:

http://www.example.com

http://www.example.com4.6.6. 创建静态网站

要创建静态网站,请执行以下步骤:

创建 S3 存储桶。bucket 名称 MIGHT 与网站的域名相同。例如,

mysite.com可能具有 bucket 名称mysite.com。AWS 需要此功能,但 Ceph 不需要它。- 详情请参阅 Red Hat Ceph Storage Object Gateway Guide 中的 静态 Web 托管 DNS 配置部分。

-

将静态网站内容上传到 bucket。内容可能包括 HTML、CSS、客户端 JavaScript、镜像、音频/视频内容和其他可下载的文件。网站 MUST 有

index.html文件,可能有一个error.html文件。 - 验证网站内容。此时,只有存储桶的创建者才能访问其内容。

- 设置文件的权限,以便可以公开读取。

4.7. Ceph 对象网关的高可用性

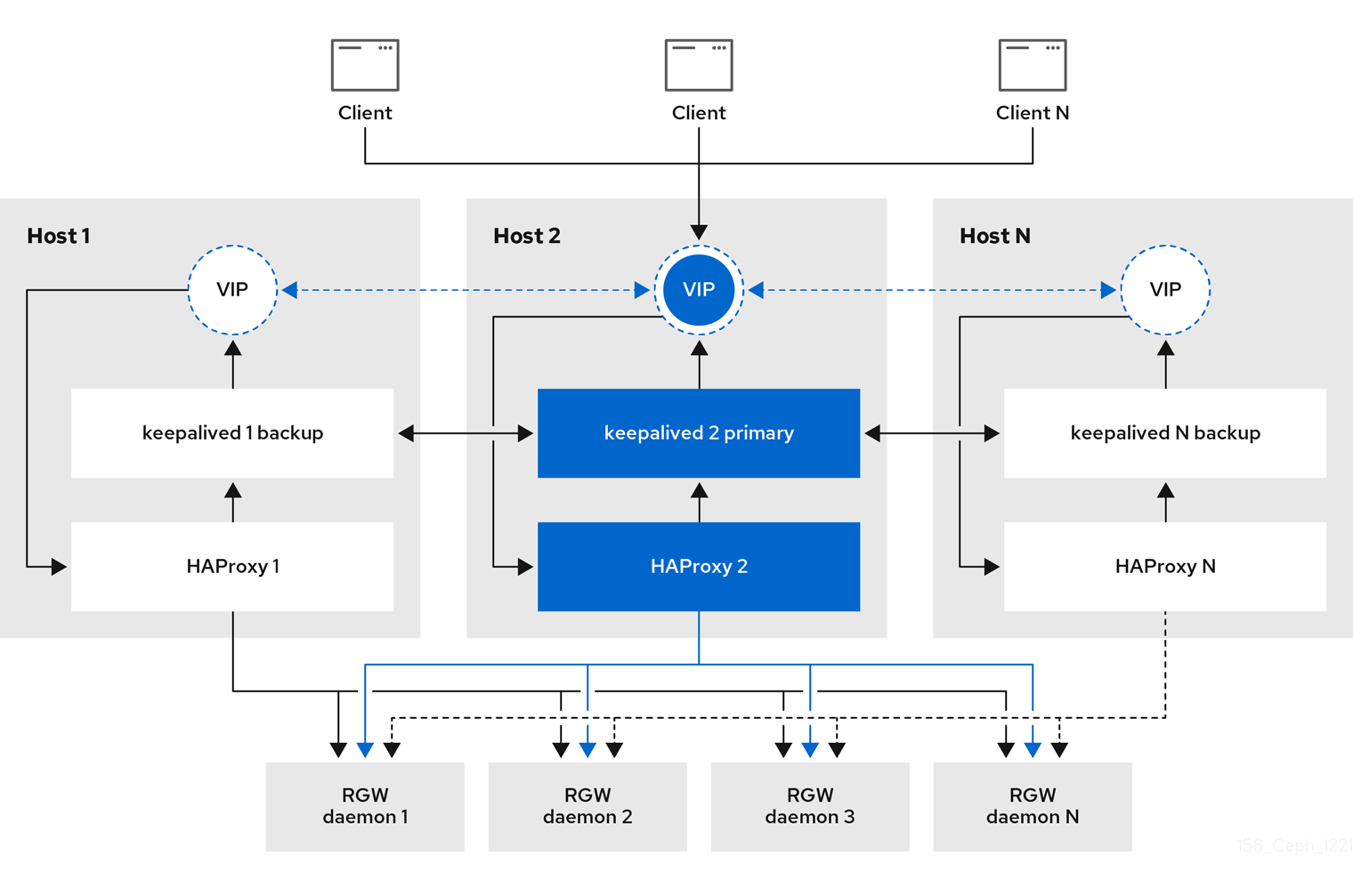

作为存储管理员,您可以将多个 Ceph 对象网关实例分配到一个区域。这样,您可以随着负载的增加而横向扩展,即同一区组和区域。但是,您不需要联合架构来使用高可用性代理。由于每个 Ceph 对象网关守护进程都有自己的 IP 地址,因此您可以使用 ingress 服务在多个 Ceph 对象网关守护进程或节点间平衡负载。入口 服务为 Ceph 对象网关环境管理 HAProxy 和 keepalived 守护进程。您还可以终止 HAProxy 服务器上的 HTTPS 流量,并在 HAProxy 服务器和 Beast 前端 web 服务器实例之间使用 HTTP 作为 Ceph 对象网关。

4.7.1. 先决条件

- 在不同主机上运行至少两个 Ceph 对象网关守护进程。

-

在不同主机上运行至少两个

入口服务实例的容量。

4.7.2. 高可用性服务

入口 服务为 Ceph 对象网关提供高度可用的端点。入口 服务可以根据需要部署到任意数量的主机。红帽建议至少有两个 Red Hat Enterprise Linux 8 服务器,每个服务器都配置了 入口 服务。您可以使用最小配置选项集合运行高可用性(HA)服务。Ceph 编排器通过提供使用浮动虚拟 IP 地址的负载平衡,部署 入口 服务来管理 haproxy 和 keepalived 守护进程。活跃的 haproxy 将所有 Ceph 对象网关请求分发到所有可用的 Ceph 对象网关守护进程。

一个虚拟 IP 地址一次会在其中一个 入口 主机上自动配置,称为主主机。Ceph 编排器基于配置为同一子网一部分的现有 IP 地址选择第一个网络接口。如果虚拟 IP 地址不属于同一个子网,则可以为 Ceph 编排器定义一个与现有 IP 地址匹配的子网列表。如果 keepalived 守护进程和活跃的 haproxy 在主主机上没有响应,则虚拟 IP 地址会移到备份主机上。此备份主机成为新的主主机。

目前,您不能在没有配置的 IP 地址的网络接口中配置虚拟 IP 地址。

要使用安全套接字层(SSL),SSL 必须由 ingress 服务终止,而不是在 Ceph 对象网关中终止。

4.7.3. 为 Ceph 对象网关配置高可用性

要为 Ceph 对象网关配置高可用性(HA),您可以编写 YAML 配置文件,Ceph 编排器负责安装、配置和管理 入口 服务。入口 服务使用 haproxy 和 keepalived 守护进程为 Ceph 对象网关提供高可用性。

先决条件

-

最少两个运行 Red Hat Enterprise Linux 8 或更高版本的主机,用于安装

入口服务。 - 正常运行的 Red Hat Ceph Storage 集群。

- 最少两个 Ceph 对象网关守护进程在不同的主机上运行。

-

对运行

入口服务的主机的根级别访问。 - 如果使用防火墙,则打开 HTTP 的端口 80,为 HTTPS 流量打开端口 443。

流程

创建一个新的

ingress.yaml文件:示例

[root@host01 ~] touch ingress.yaml

[root@host01 ~] touch ingress.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 打开

ingress.yaml文件进行编辑。添加了以下选项,并添加适用于环境的值:语法

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 启动 Cephadm shell:

示例

cephadm shell --mount ingress.yaml:/var/lib/ceph/radosgw/igress.yaml

[root@host01 ~]# cephadm shell --mount ingress.yaml:/var/lib/ceph/radosgw/igress.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 配置最新的

haproxy和keepalived镜像:语法

ceph config set mgr mgr/cephadm/container_image_haproxy HAPROXY_IMAGE_ID ceph config set mgr mgr/cephadm/container_image_keepalived KEEPALIVED_IMAGE_ID

ceph config set mgr mgr/cephadm/container_image_haproxy HAPROXY_IMAGE_ID ceph config set mgr mgr/cephadm/container_image_keepalived KEEPALIVED_IMAGE_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph config set mgr mgr/cephadm/container_image_haproxy registry.redhat.io/rhceph/rhceph-haproxy-rhel8:latest [ceph: root@host01 /]# ceph config set mgr mgr/cephadm/container_image_keepalived registry.redhat.io/rhceph/keepalived-rhel8:latest

[ceph: root@host01 /]# ceph config set mgr mgr/cephadm/container_image_haproxy registry.redhat.io/rhceph/rhceph-haproxy-rhel8:latest [ceph: root@host01 /]# ceph config set mgr mgr/cephadm/container_image_keepalived registry.redhat.io/rhceph/keepalived-rhel8:latestCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用 Ceph 编配器安装和配置新的

入口服务:[ceph: root@host01 /]# ceph orch apply -i ingress.yaml

[ceph: root@host01 /]# ceph orch apply -i ingress.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在 Ceph 编排器完成后,验证 HA 配置。

在运行

ingress服务的主机上,检查是否显示虚拟 IP 地址:示例

ip addr show

[root@host01 ~]# ip addr showCopy to Clipboard Copied! Toggle word wrap Toggle overflow 尝试从 Ceph 客户端访问 Ceph 对象网关:

语法

wget HOST_NAME

wget HOST_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

wget host01.example.com

[root@client ~]# wget host01.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果此操作返回带有类似内容的

index.html,则 Ceph 对象网关的 HA 配置可以正常工作。示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.7.4. HAProxy 和 keepalived

作为存储管理员,您可以将多个 Ceph 对象网关实例分配到一个区域。这允许您随着负载的增加(即相同的 zone group 和 zone)向外扩展,但您不需要联合架构来使用 HAProxy 和 keepalived。由于每个对象网关实例都有自己的 IP 地址,因此您可以使用 HAProxy 和 keepalived 在 Ceph 对象网关服务器之间平衡负载。

HAProxy 和 keepalived 的另一个用例是在 HAProxy 服务器上终止 HTTPS。您可以使用 HAProxy 服务器在 HAProxy 服务器上终止 HTTPS,并在 HAProxy 服务器和 Beast web 服务器实例之间使用 HTTP。

4.7.4.1. HAProxy/keepalived 先决条件

要使用 Ceph 对象网关设置 HAProxy,您必须有:

- 正在运行的 Red Hat Ceph Storage 集群

-

同一区域中至少有两个 Ceph 对象网关服务器配置为在端口

80上运行。如果您遵循简单的安装过程,网关实例默认位于同一 zone group 和 zone 中。如果您使用联合架构,请确保实例位于同一 zone group 和 zone 中。 -

至少两台 Red Hat Enterprise Linux 8 服务器用于 HAProxy 和

keepalived。

本节假定您在运行测试脚本时至少有两个 Ceph 对象网关服务器运行,并且您在通过端口 80 运行测试脚本时从各自获得有效的响应。

4.7.4.2. 准备 HAProxy 节点

以下设置假定两个名为 haproxy 和 haproxy2 的 HAProxy 节点,以及名为 rgw1 和 rgw2 的 Ceph 对象网关服务器。您可以使用您喜欢的任何命名规则。在至少两个 HAProxy 节点上执行以下步骤:

- 安装 Red Hat Enterprise Linux 8 或 9。

注册节点。

subscription-manager register

[root@haproxy]# subscription-manager registerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 启用 RHEL 服务器存储库。

Red Hat Enterprise Linux 9

subscription-manager repos --enable=rhel-9-server-rpms

[root@haproxy]# subscription-manager repos --enable=rhel-9-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 8

subscription-manager repos --enable=rhel-8-server-rpms

[root@haproxy]# subscription-manager repos --enable=rhel-8-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 更新服务器。

dnf update -y

[root@haproxy]# dnf update -yCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

根据需要安装管理工具(如

wget、vim等)。 打开端口

80。firewall-cmd --zone=public --add-port 80/tcp --permanent firewall-cmd --reload

[root@haproxy]# firewall-cmd --zone=public --add-port 80/tcp --permanent [root@haproxy]# firewall-cmd --reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow 对于 HTTPS,打开端口

443。firewall-cmd --zone=public --add-port 443/tcp --permanent firewall-cmd --reload

[root@haproxy]# firewall-cmd --zone=public --add-port 443/tcp --permanent [root@haproxy]# firewall-cmd --reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.7.4.3. 安装和配置 keepalived

在至少两个 HAProxy 节点上执行以下步骤:

先决条件

- 至少两个 HAProxy 节点。

- 至少两个对象网关节点。

流程

安装

keepalived:yum install -y keepalived

[root@haproxy]# yum install -y keepalivedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 配置

keepalived在两个 HAProxy 节点上:vim /etc/keepalived/keepalived.conf

[root@haproxy]# vim /etc/keepalived/keepalived.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在配置文件中,有一个用于检查

haproxy进程脚本:vrrp_script chk_haproxy { script "killall -0 haproxy" # check the haproxy process interval 2 # every 2 seconds weight 2 # add 2 points if OK }vrrp_script chk_haproxy { script "killall -0 haproxy" # check the haproxy process interval 2 # every 2 seconds weight 2 # add 2 points if OK }Copy to Clipboard Copied! Toggle word wrap Toggle overflow 接下来,主负载平衡器和备份负载平衡器中的实例使用

eno1作为网络接口。它还分配虚拟 IP 地址,即192.168.1.20。主负载均衡器节点

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 备份负载均衡器节点

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 启用并启动

keepalived服务:systemctl enable keepalived systemctl start keepalived

[root@haproxy]# systemctl enable keepalived [root@haproxy]# systemctl start keepalivedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

其它资源

-

有关使用

keepalived的详情,请参阅 使用 Keepalived 设置 Linux 集群:红帽客户门户上的基本配置 文章。

4.7.4.4. 安装和配置 HAProxy

在至少两个 HAProxy 节点上执行以下步骤:

安装

haproxy。dnf install haproxy

[root@haproxy]# dnf install haproxyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 为 SELinux 和 HTTP 配置

haproxy。vim /etc/firewalld/services/haproxy-http.xml

[root@haproxy]# vim /etc/firewalld/services/haproxy-http.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 添加以下行:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以

root身份,为haproxy-http.xml文件分配正确的 SELinux 上下文和文件权限。cd /etc/firewalld/services restorecon haproxy-http.xml chmod 640 haproxy-http.xml

[root@haproxy]# cd /etc/firewalld/services [root@haproxy]# restorecon haproxy-http.xml [root@haproxy]# chmod 640 haproxy-http.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果要使用 HTTPS,请为 SELinux 和 HTTPS 配置

haproxy。vim /etc/firewalld/services/haproxy-https.xml

[root@haproxy]# vim /etc/firewalld/services/haproxy-https.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 添加以下行:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以

root身份,为haproxy-https.xml文件分配正确的 SELinux 上下文和文件权限。cd /etc/firewalld/services restorecon haproxy-https.xml chmod 640 haproxy-https.xml

# cd /etc/firewalld/services # restorecon haproxy-https.xml # chmod 640 haproxy-https.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果您打算使用 HTTPS,请为 SSL 生成密钥。如果您没有证书,您可以使用自签名证书。

最后,将证书和密钥放入 PEM 文件中。

[root@haproxy]# cat example.com.crt example.com.key > example.com.pem [root@haproxy]# cp example.com.pem /etc/ssl/private/

[root@haproxy]# cat example.com.crt example.com.key > example.com.pem [root@haproxy]# cp example.com.pem /etc/ssl/private/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 配置

haproxy。vim /etc/haproxy/haproxy.cfg

[root@haproxy]# vim /etc/haproxy/haproxy.cfgCopy to Clipboard Copied! Toggle word wrap Toggle overflow global和defaults可以保持不变。在defaults部分后,您需要配置frontend和backend部分。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 有关 HAProxy 配置的详情,请参考红帽更新基础架构系统管理员指南中的添加 HAProxy 负载平衡器章节。

Enable/start

haproxysystemctl enable haproxy systemctl start haproxy

[root@haproxy]# systemctl enable haproxy [root@haproxy]# systemctl start haproxyCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.7.4.5. 测试 HAProxy 配置

在 HAProxy 节点上,确保出现来自

keepalived配置的虚拟 IP 地址。ip addr show

[root@haproxy]# ip addr showCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在托管 Red Hat Ceph Dashboard 容器的节点上,查看您是否能使用负载平衡器配置来访问 Ceph 对象网关节点。例如:

wget haproxy

[root@haproxy]# wget haproxyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 这应该返回相同的结果,如下:

wget rgw1

[root@haproxy]# wget rgw1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果返回包含以下内容的

index.html文件:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 然后,您的配置可以正常工作。

4.8. 将命名空间导出到 NFS-Ganesha

若要配置新的 NFS Ganesha 导出以用于 Ceph 对象网关,您必须使用 Red Hat Ceph Dashboard。如需了解更多详细信息,请参阅 Red Hat Ceph Storage Dashboard 指南中的管理 Ceph 控制面板上导出的 NFS Ganesha。

对于使用 Ceph 对象网关的现有 NFS 环境,目前不支持从 Red Hat Ceph Storage 4 升级到 Red Hat Ceph Storage 5。

红帽不支持使用 Ceph 对象网关导出 NFS 版本 3。

第 5 章 高级配置

作为存储管理员,您可以配置 Ceph 对象网关的一些更高级功能。您可以配置多站点 Ceph 对象网关,并将其与目录服务(如 Microsoft Active Directory 和 OpenStack Keystone 服务)集成。

5.1. 先决条件

- 一个正常运行的 Red Hat Ceph Storage 集群。

5.2. 多站点配置和管理

作为存储管理员,您可以为各种用例配置和管理多个 Ceph 对象网关。您可以了解在灾难恢复和故障转移事件期间要做什么。另外,您可以在多站点 Ceph 对象网关环境中了解更多有关 realms、zone 和 syncing 策略的信息。

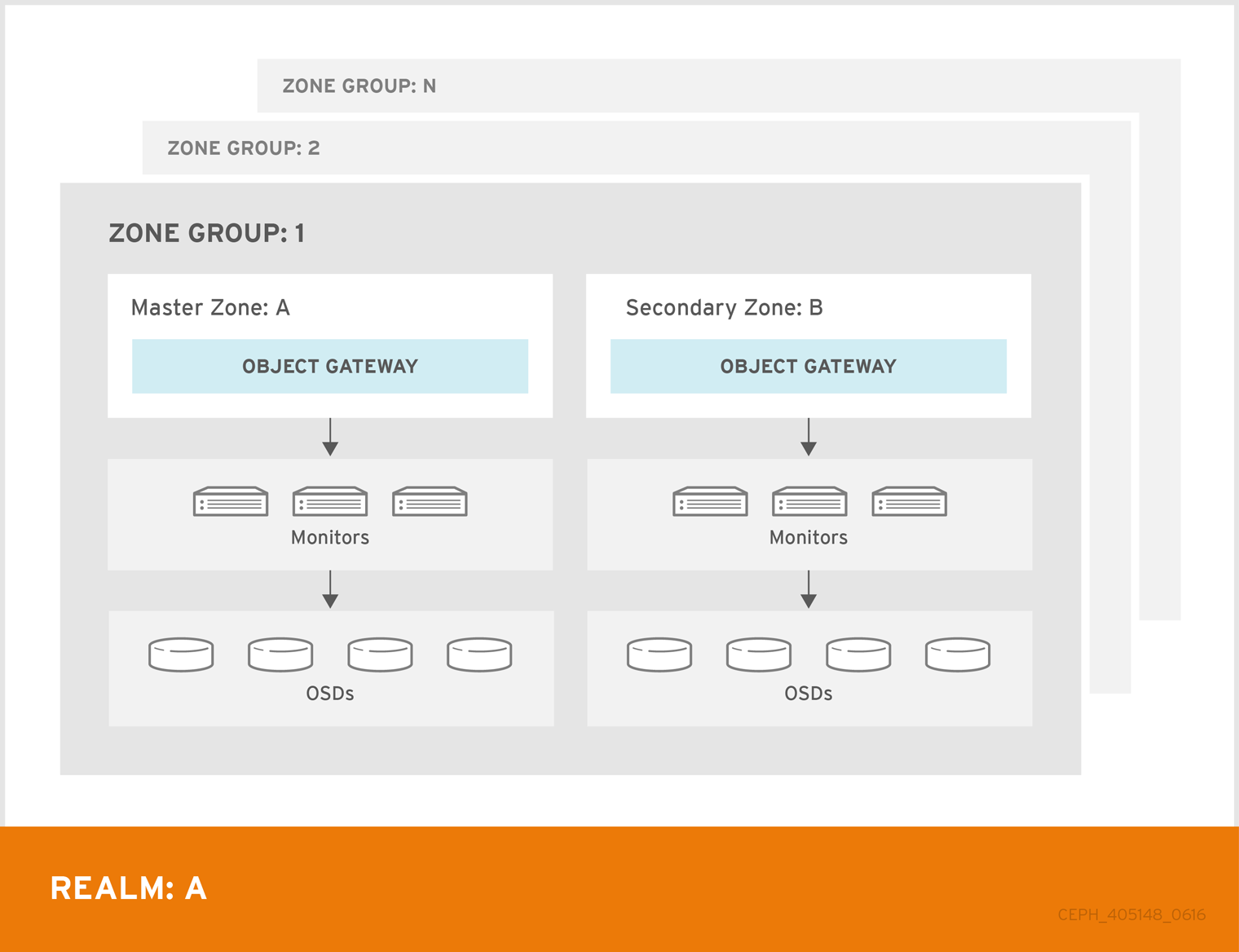

单个 zone 配置通常由一个 zone 和一个 zone group 和一个或者多个 ceph-radosgw 实例组成,您可以在实例之间对网关客户端请求进行负载平衡。在单一区域配置中,通常多个网关实例指向一个 Ceph 存储集群。但是,红帽支持 Ceph 对象网关的几个多站点配置选项:

-

多区 : 更高级的配置由一个 zone group 和多个 zone 组成,每个 zone 都有一个或多个

ceph-radosgw实例。每个区域都由自己的 Ceph Storage 集群支持。zone group 中的多个 zone 为 zone group 提供灾难恢复,应该其中一个区域遇到了很大的故障。每个区域都处于活跃状态,并可能会接收写操作。除了灾难恢复外,多个活动区域也可能充当内容交付网络的基础。 - multi-zone-group: Formerly called 'regions',Ceph 对象网关也可以支持多个 zone group,每个 zone group 都包含一个或多个 zone。存储在同一域中的 zone group 的对象共享一个全局命名空间,确保 zone group 和 zone 的唯一对象 ID。

- 多个 Realms: Ceph 对象网关支持域的概念,可以是单个 zone group 或多个 zone group,以及域的全局唯一命名空间。多个域提供支持大量配置和命名空间的功能。

先决条件

- 一个正常运行的 Red Hat Ceph Storage 集群。

- 部署 Ceph 对象网关软件。

5.2.1. 要求和假设

多站点配置至少需要两个 Ceph 存储集群,以及至少两个 Ceph 对象网关实例,每个 Ceph 存储集群一个。

本指南假设在地理上至少有两个 Ceph 存储集群,但配置可以在同一物理站点上工作。本指南还假定四个 Ceph 对象网关服务器分别名为 rgw1、 rgw2、 rgw3 和 rgw4。

多站点配置需要一个 master zone group 和 master zone。此外,每个 zone group 都需要一个 master zone。zone group 可能具有一个或多个次要或非 master 区域。

在规划多站点的网络注意事项时,务必要了解多站点同步网络上观察到的关系带宽和延迟,客户端与与二级站点当前同步状态直接相关客户端。Red Hat Ceph Storage 多站点集群之间的网络链接必须能够处理主要集群,以便在次要站点上保持有效的恢复时间。多站点同步是异步的,其中一个限制是同步网关可以在链路间处理数据的速率。以下是网络互连速度的一个示例,可以是 1GbE 或非数据中心连接,每个客户端网关的每个 8 TB 或累积接收数据。因此,如果您复制到两个其他站点,并且每天需要 16 TB,则多站点复制需要 6 GbE 专用带宽。

红帽还建议将私有以太网或 Dense wavelength-division 多路(DWDM)作为互联网上的 VPN 来说,因为产生额外的开销并不理想。

域 master zone group 中的 master zone 负责存储域元数据的主副本,包括用户、配额和存储桶(由 radosgw-admin CLI 创建)。此元数据会自动同步到 second zone 和 second zone group。使用 radosgw-admin CLI 执行的元数据操作必须在 master zone group 的 master zone 中的主机上执行,以确保它们与 second zone group 和 zone 同步。目前,可以对二级域和域组执行元数据操作,但不建议这么做,因为它们不会被同步,从而导致元数据碎片。

在以下示例中,rgw1 主机将充当 master zone group 的 master zone; rgw2 主机将充当 master zone group 的 second zone; rgw3 主机将充当 second zone group 的 master zone;而 rgw4 主机将充当 second zone group 的次要 zone。

当您在多站点存储集群中配置了多个 Ceph 对象网关的大型集群时,红帽建议每个站点使用带有 HAProxy 负载均衡器的 HAProxy 负载均衡器的专用的 Ceph 对象网关。如果 Ceph 对象网关超过三个同步,则性能方面的返回同步率会降低,增加争用会导致按与时间相关的错误条件造成增量风险。这是因为一个 sync-fairness 的已知问题 BZ#1740782。

对于此类配置中其余的 Ceph 对象网关(通过负载均衡器专用于客户端 I/O 操作),请运行 ceph config set client.rgw.CLIENT_NODE rgw_run_sync_thread false 命令,以防止它们执行同步操作,然后重启 Ceph 对象网关。

以下是用于同步网关的 HAProxy 的典型配置文件:

示例

5.2.2. 池

红帽建议使用 Ceph Placement Group’s per Pool Calculator 来计算要创建 radosgw 守护进程的池的放置组的适当数量。在 Ceph 配置数据库中将计算的值设置为默认值。

示例

[ceph: root@host01 /]# ceph config set osd osd_pool_default_pg_num 50 [ceph: root@host01 /]# ceph config set osd osd_pool_default_pgp_num 50

[ceph: root@host01 /]# ceph config set osd osd_pool_default_pg_num 50

[ceph: root@host01 /]# ceph config set osd osd_pool_default_pgp_num 50在 Ceph 对象网关实例创建池时,对 Ceph 配置进行此更改将使用这些默认值。或者,您也可以手动创建池。

特定于区域的池名称遵循命名规则 ZONE_NAME.POOL_NAME。例如,名为 us-east 的区域将具有以下池:

-

.rgw.root -

us-east.rgw.control -

us-east.rgw.meta -

us-east.rgw.log -

us-east.rgw.buckets.index -

us-east.rgw.buckets.data -

us-east.rgw.buckets.non-ec -

us-east.rgw.meta:users.keys -

us-east.rgw.meta:users.email -

us-east.rgw.meta:users.swift -

us-east.rgw.meta:users.uid

5.2.3. 将单个站点系统迁移到多站点

要从带有 默认区 组和区的单一站点系统迁移到多站点系统,请使用以下步骤:

创建 realm。使用域名替换

NAME。语法

radosgw-admin realm create --rgw-realm=NAME --default

radosgw-admin realm create --rgw-realm=NAME --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重命名默认区域和 zonegroup。将

<name>替换为 zonegroup 或 zone name。语法

radosgw-admin zonegroup rename --rgw-zonegroup default --zonegroup-new-name=NEW_ZONE_GROUP_NAME radosgw-admin zone rename --rgw-zone default --zone-new-name us-east-1 --rgw-zonegroup=ZONE_GROUP_NAME

radosgw-admin zonegroup rename --rgw-zonegroup default --zonegroup-new-name=NEW_ZONE_GROUP_NAME radosgw-admin zone rename --rgw-zone default --zone-new-name us-east-1 --rgw-zonegroup=ZONE_GROUP_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 配置主要 zonegroup。使用 realm 或 zonegroup 名称替换

NAME。使用 zonegroup 中完全限定域名替换FQDN。语法

radosgw-admin zonegroup modify --rgw-realm=REALM_NAME --rgw-zonegroup=ZONE_GROUP_NAME --endpoints http://FQDN:80 --master --default

radosgw-admin zonegroup modify --rgw-realm=REALM_NAME --rgw-zonegroup=ZONE_GROUP_NAME --endpoints http://FQDN:80 --master --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建系统用户。使用用户名替换

USER_ID。将DISPLAY_NAME替换为显示名称。它可以包含空格。语法

radosgw-admin user create --uid=USER_ID \ --display-name="DISPLAY_NAME" \ --access-key=ACCESS_KEY --secret=SECRET_KEY \ --systemradosgw-admin user create --uid=USER_ID \ --display-name="DISPLAY_NAME" \ --access-key=ACCESS_KEY --secret=SECRET_KEY \ --systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 配置主区域。使用 realm、zonegroup 或 zone name 替换

NAME。使用 zonegroup 中完全限定域名替换FQDN。语法

radosgw-admin zone modify --rgw-realm=REALM_NAME --rgw-zonegroup=ZONE_GROUP_NAME \ --rgw-zone=ZONE_NAME --endpoints http://FQDN:80 \ --access-key=ACCESS_KEY --secret=SECRET_KEY \ --master --defaultradosgw-admin zone modify --rgw-realm=REALM_NAME --rgw-zonegroup=ZONE_GROUP_NAME \ --rgw-zone=ZONE_NAME --endpoints http://FQDN:80 \ --access-key=ACCESS_KEY --secret=SECRET_KEY \ --master --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:如果您在 Ceph 对象网关部署期间在服务规格中指定 realm 和 zone,请更新规范文件的

spec部分:语法

spec: rgw_realm: REALM_NAME rgw_zone: ZONE_NAME

spec: rgw_realm: REALM_NAME rgw_zone: ZONE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 更新 Ceph 配置数据库:

语法

ceph config set client.rgw.SERVICE_NAME rgw_realm REALM_NAME ceph config set client.rgw.SERVICE_NAME rgw_zonegroup ZONE_GROUP_NAME ceph config set client.rgw.SERVICE_NAME rgw_zone PRIMARY_ZONE_NAME

ceph config set client.rgw.SERVICE_NAME rgw_realm REALM_NAME ceph config set client.rgw.SERVICE_NAME rgw_zonegroup ZONE_GROUP_NAME ceph config set client.rgw.SERVICE_NAME rgw_zone PRIMARY_ZONE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph config set client.rgw.rgwsvcid.mons-1.jwgwwp rgw_realm test_realm [ceph: root@host01 /]# ceph config set client.rgw.rgwsvcid.mons-1.jwgwwp rgw_zonegroup us [ceph: root@host01 /]# ceph config set client.rgw.rgwsvcid.mons-1.jwgwwp rgw_zone us-east-1

[ceph: root@host01 /]# ceph config set client.rgw.rgwsvcid.mons-1.jwgwwp rgw_realm test_realm [ceph: root@host01 /]# ceph config set client.rgw.rgwsvcid.mons-1.jwgwwp rgw_zonegroup us [ceph: root@host01 /]# ceph config set client.rgw.rgwsvcid.mons-1.jwgwwp rgw_zone us-east-1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 提交更新的配置:

示例

[ceph: root@host01 /]# radosgw-admin period update --commit

[ceph: root@host01 /]# radosgw-admin period update --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重启 Ceph 对象网关:

注意使用

ceph orch ps命令的输出(在NAME列下),获取 SERVICE_TYPE.ID 信息。要在存储集群中的单个节点上重启 Ceph 对象网关:

语法

systemctl restart ceph-CLUSTER_ID@SERVICE_TYPE.ID.service

systemctl restart ceph-CLUSTER_ID@SERVICE_TYPE.ID.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

systemctl restart ceph-c4b34c6f-8365-11ba-dc31-529020a7702d@rgw.realm.zone.host01.gwasto.service

[root@host01 ~]# systemctl restart ceph-c4b34c6f-8365-11ba-dc31-529020a7702d@rgw.realm.zone.host01.gwasto.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在存储集群的所有节点上重启 Ceph 对象网关:

语法

ceph orch restart SERVICE_TYPE

ceph orch restart SERVICE_TYPECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph orch restart rgw

[ceph: root@host01 /]# ceph orch restart rgwCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- 建立 second zone。请参阅 建立 second zone 部分。

5.2.4. 建立 second zone

区组群中的区复制所有数据以确保每个区都有相同的数据。在创建二级 zone 时,在标识为服务二级 zone 的主机上执行所有 radosgw-admin zone 操作。

要添加其他区域,其步骤与添加二级 zone 相同。使用不同的区名称。

-

您必须在 master zonegroup 的 master 区域中主机上运行元数据操作,如用户创建和配额。master zone 和 second zone 可以从 RESTful API 接收存储桶操作,但 second zone 会将存储桶操作重定向到 master zone。如果 master zone 停机,存储桶操作将失败。如果使用 ctlplane

-adminCLI 创建存储桶,您必须在 master zone group 的 master 区的主机上运行它,以便存储桶与其他 zone group 和 zone 同步。 -

不支持为特定用户创建存储桶,即使您在 second zone 中创建具有

--yes-i-really-mean-it的用户。

先决条件

- 至少两个正在运行的 Red Hat Ceph Storage 集群。

- 至少两个 Ceph 对象网关实例,每个实例对应一个 Red Hat Ceph Storage 集群。

- 所有节点的根级别访问权限。

- 节点或容器添加到存储集群中。

- 部署所有 Ceph Manager、监控和 OSD 守护进程。

流程

登录

cephadmshell:示例

cephadm shell

[root@host04 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow 从主机拉取主要域配置:

语法

radosgw-admin realm pull --url=URL_TO_PRIMARY_ZONE_GATEWAY --access-key=ACCESS_KEY --secret-key=SECRET_KEY

radosgw-admin realm pull --url=URL_TO_PRIMARY_ZONE_GATEWAY --access-key=ACCESS_KEY --secret-key=SECRET_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host04 /]# radosgw-admin realm pull --url=http://10.74.249.26:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQ

[ceph: root@host04 /]# radosgw-admin realm pull --url=http://10.74.249.26:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQCopy to Clipboard Copied! Toggle word wrap Toggle overflow 从主机拉取主要 period 配置:

语法

radosgw-admin period pull --url=URL_TO_PRIMARY_ZONE_GATEWAY --access-key=ACCESS_KEY --secret-key=SECRET_KEY

radosgw-admin period pull --url=URL_TO_PRIMARY_ZONE_GATEWAY --access-key=ACCESS_KEY --secret-key=SECRET_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host04 /]# radosgw-admin period pull --url=http://10.74.249.26:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQ

[ceph: root@host04 /]# radosgw-admin period pull --url=http://10.74.249.26:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQCopy to Clipboard Copied! Toggle word wrap Toggle overflow 配置 second zone:

注意所有区域默认在主动配置中运行;也就是说,网关客户端可能会向任何区写入数据,区会将数据复制到该 zone group 中所有其他区域。如果 second zone 不接受写操作,请指定

'--read-only标志,以在 master zone 和 second zone 之间创建一个主动-被动配置。另外,提供生成的系统用户的access_key和secret_key存储在 master zone group 的 master zone 中。语法

radosgw-admin zone create --rgw-zonegroup=_ZONE_GROUP_NAME_ \ --rgw-zone=_SECONDARY_ZONE_NAME_ --endpoints=http://_RGW_SECONDARY_HOSTNAME_:_RGW_PRIMARY_PORT_NUMBER_1_ \ --access-key=_SYSTEM_ACCESS_KEY_ --secret=_SYSTEM_SECRET_KEY_ \ [--read-only]radosgw-admin zone create --rgw-zonegroup=_ZONE_GROUP_NAME_ \ --rgw-zone=_SECONDARY_ZONE_NAME_ --endpoints=http://_RGW_SECONDARY_HOSTNAME_:_RGW_PRIMARY_PORT_NUMBER_1_ \ --access-key=_SYSTEM_ACCESS_KEY_ --secret=_SYSTEM_SECRET_KEY_ \ [--read-only]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host04 /]# radosgw-admin zone create --rgw-zonegroup=us --rgw-zone=us-east-2 --endpoints=http://rgw2:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQ

[ceph: root@host04 /]# radosgw-admin zone create --rgw-zonegroup=us --rgw-zone=us-east-2 --endpoints=http://rgw2:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQCopy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:删除默认区:

重要如果您使用默认 zone 和 zone group 存储数据,则不要删除默认区域及其池。

示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:如果您在 Ceph 对象网关部署期间在服务规格中指定 realm 和 zone,请更新规范文件的

spec部分:语法

spec: rgw_realm: REALM_NAME rgw_zone: ZONE_NAME

spec: rgw_realm: REALM_NAME rgw_zone: ZONE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 更新 Ceph 配置数据库:

语法

ceph config set client.rgw.SERVICE_NAME rgw_realm REALM_NAME ceph config set client.rgw.SERVICE_NAME rgw_zonegroup ZONE_GROUP_NAME ceph config set client.rgw.SERVICE_NAME rgw_zone SECONDARY_ZONE_NAME

ceph config set client.rgw.SERVICE_NAME rgw_realm REALM_NAME ceph config set client.rgw.SERVICE_NAME rgw_zonegroup ZONE_GROUP_NAME ceph config set client.rgw.SERVICE_NAME rgw_zone SECONDARY_ZONE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host04 /]# ceph config set client.rgw.rgwsvcid.mons-1.jwgwwp rgw_realm test_realm [ceph: root@host04 /]# ceph config set client.rgw.rgwsvcid.mons-1.jwgwwp rgw_zonegroup us [ceph: root@host04 /]# ceph config set client.rgw.rgwsvcid.mons-1.jwgwwp rgw_zone us-east-2

[ceph: root@host04 /]# ceph config set client.rgw.rgwsvcid.mons-1.jwgwwp rgw_realm test_realm [ceph: root@host04 /]# ceph config set client.rgw.rgwsvcid.mons-1.jwgwwp rgw_zonegroup us [ceph: root@host04 /]# ceph config set client.rgw.rgwsvcid.mons-1.jwgwwp rgw_zone us-east-2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 提交更改:

语法

radosgw-admin period update --commit

radosgw-admin period update --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host04 /]# radosgw-admin period update --commit

[ceph: root@host04 /]# radosgw-admin period update --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

cephadmshell 外部,获取存储集群和进程的 FSID:示例

systemctl list-units | grep ceph

[root@host04 ~]# systemctl list-units | grep cephCopy to Clipboard Copied! Toggle word wrap Toggle overflow 启动 Ceph 对象网关守护进程:

语法

systemctl start ceph-FSID@DAEMON_NAME systemctl enable ceph-FSID@DAEMON_NAME

systemctl start ceph-FSID@DAEMON_NAME systemctl enable ceph-FSID@DAEMON_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

systemctl start ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-2.host04.ahdtsw.service systemctl enable ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-2.host04.ahdtsw.service

[root@host04 ~]# systemctl start ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-2.host04.ahdtsw.service [root@host04 ~]# systemctl enable ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-2.host04.ahdtsw.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2.5. 配置存档区(技术预览)

在将区域配置为存档之前,请确保您有一个域。如果没有域,则无法通过默认 zone/zonegroups 的归档区域归档数据。

存档同步模块使用 Ceph 对象网关中 S3 对象的版本控制功能来具有存档区域。archive 区域具有 S3 对象的版本历史记录,只能通过与存档区域关联的网关删除。它捕获所有数据更新和元数据,将它们整合为 S3 对象的版本。

归档同步模块只是一个技术预览功能。红帽产品服务级别协议(SLA)不支持技术预览功能,且其功能可能并不完善,因此红帽不建议在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。如需了解更多详细信息,请参阅红帽技术预览功能的支持范围。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- Ceph 监控节点的根级别访问权限.

- 安装 Ceph 对象网关软件.

流程

在使用归档层创建新区时配置

归档区:语法

radosgw-admin zone create --rgw-zonegroup={ZONE_GROUP_NAME} --rgw-zone={ZONE_NAME} --endpoints={http://FQDN:PORT},{http://FQDN:PORT} --tier-type=archiveradosgw-admin zone create --rgw-zonegroup={ZONE_GROUP_NAME} --rgw-zone={ZONE_NAME} --endpoints={http://FQDN:PORT},{http://FQDN:PORT} --tier-type=archiveCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# radosgw-admin zone create --rgw-zonegroup=us --rgw-zone=us-east --endpoints={http://example.com:8080} --tier-type=archive[ceph: root@host01 /]# radosgw-admin zone create --rgw-zonegroup=us --rgw-zone=us-east --endpoints={http://example.com:8080} --tier-type=archiveCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2.5.1. 删除存档区中的对象

您可以使用 S3 生命周期策略扩展来删除 < ArchiveZone> 元素中的对象。

归档区对象只能使用 过期 生命周期策略规则删除。

-

如果任何 &

lt;Rule> 部分包含一个<ArchiveZone> 元素,则该规则在归档区中执行,并且只能执行在归档区中运行的规则。 -

标记为 &

lt;ArchiveZone> 的规则不会在非存档区域中执行。

生命周期策略中的规则决定了要删除的对象。有关生命周期创建和管理的更多信息,请参阅 Bucket 生命周期。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- Ceph 监控节点的根级别访问权限.

- 安装 Ceph 对象网关软件.

流程

设置 <

;ArchiveZone> 生命周期策略规则。有关创建生命周期策略的更多信息,请参阅 Red Hat Ceph Storage Object Gateway 指南中的创建生命周期管理策略部分。 https://access.redhat.com/documentation/zh-cn/red_hat_ceph_storage/5/html-single/object_gateway_guide/#creating-a-lifecycle-management-policy示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:查看特定生命周期策略是否包含归档区规则。

语法

radosgw-admin lc get --bucket BUCKET_NAME

radosgw-admin lc get --bucket BUCKET_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例