仪表板指南

使用 Ceph Dashboard 监控 Ceph 集群

摘要

第 1 章 Ceph 仪表板概述

作为存储管理员,Red Hat Ceph Storage 控制面板提供管理和监控功能,允许您管理和监控集群,以及视觉化与其相关的信息和性能统计信息。控制面板使用由 ceph-mgr 守护进程托管的 Web 服务器。

控制面板可从 Web 浏览器访问,包含许多有用的管理和监控功能,例如配置管理器模块并监控 OSD 状态。

Ceph 仪表板提供以下功能:

- 多用户和角色管理

控制面板支持多个具有不同权限和角色的用户帐户。可以使用命令行和 Web 用户界面来管理用户帐户和角色。控制面板支持多种增强密码安全性的方法。可以配置密码复杂性规则,要求用户在登录后或可配置的时间段后更改密码。

有关更多信息,请参阅在 Ceph 控制面板中管理角色, 以及在 Ceph 控制面板中管理用户。

- 单点登录(SSO)

控制面板支持使用 SAML 2.0 协议与外部身份提供程序进行身份验证。

有关更多信息 ,请参阅为 Ceph 仪表板启用单点登录。

- Auditing

仪表板后端可以配置为记录 Ceph 管理器日志中的所有 PUT、POST 和 DELETE API 请求。

有关在仪表板中使用管理器模块的更多信息,请参阅控制面板 上查看和编辑 Ceph 集群的管理器模块。

管理功能

Red Hat Ceph Storage 控制面板包含各种管理功能。

- 查看集群层次结构

例如,您可以查看 CRUSH map,以确定特定 OSD ID 正在运行的主机。如果 OSD 出现问题,这非常有用。

有关更多信息,请参阅 在仪表板上查看 Ceph 集群的 CRUSH map。

- 配置管理器模块

您可以查看和更改 Ceph 管理器模块的参数。

有关更多信息,请参阅 在仪表板上查看和编辑 Ceph 集群的管理器模块。

- 嵌入式 Grafana 仪表板

Ceph Dashboard Grafana 仪表板可能会嵌入到外部应用程序和网页中,以提供有关 Prometheus 模块收集性能指标的信息。

有关更多信息,请参阅 Ceph 控制面板组件。

- 查看和过滤日志

您可以查看事件并审核集群日志,并根据优先级、关键字、日期或时间范围过滤它们。

有关更多信息,请参阅 控制面板上 Ceph 集群的过滤日志。

- 切换仪表板组件

您可以启用和禁用仪表板组件,以便只有您需要的功能可用。

有关更多信息,请参阅 切换 Ceph 仪表板功能。

- 管理 OSD 设置

您可以使用控制面板设置集群范围的 OSD 标志。您也可以将 OSD 标记为 up、down 或 out,清除和重新加权 OSD,执行清理操作,修改各种清理相关配置选项,选择 profile 以调整回填活动级别。您可以设置和更改 OSD 的设备类别,按设备类别显示和排序 OSD。您可以在新的驱动器和主机上部署 OSD。

有关更多信息,请参阅 在仪表板上管理 Ceph OSD。

- 查看警报

警报页面允许您查看当前警报的详情。

有关更多信息,请参阅查看 Ceph 仪表板上的警报。

- 升级

您可以使用仪表板升级 Ceph 集群版本。

如需更多信息,请参阅 升级集群。

- 镜像的服务质量

您可以对镜像设置性能限制,例如限制 IOPS 或读取 BPS burst 速率。

有关更多信息,请参阅在 Ceph 控制面板中管理块设备镜像。

监控功能

在 Red Hat Ceph Storage Dashboard 中监控不同的功能。

- 用户名和密码保护

您只能通过提供可配置的用户名和密码来访问仪表板。

有关更多信息,请参阅 在 Ceph 控制面板中管理用户。

- 集群的整体健康状况

显示性能和容量指标。这还显示总体集群状态、存储利用率,例如对象数量、原始容量、每个池的使用情况、池列表及其状态和用量统计。

有关更多信息,请参阅 在仪表板上查看和编辑 Ceph 集群的配置。

- 主机

提供与集群关联的所有主机的列表,以及运行的服务和已安装的 Ceph 版本。

有关更多信息,请参阅 在仪表板上监控 Ceph 集群的主机。

- 性能计数器

显示每个正在运行的服务的详细统计信息。

有关更多信息,请参阅 控制面板上 Ceph 集群的监控服务。

- Monitors

列出所有 monitor、其仲裁状态和打开的会话。

有关更多信息,请参阅 仪表板上的 Ceph 集群的监控监控器。

- 配置编辑器

显示所有可用的配置选项、描述、类型、默认值和当前设置的值。这些值可编辑。

有关更多信息,请参阅 在仪表板上查看和编辑 Ceph 集群的配置。

- 集群日志

显示并过滤集群事件的最新更新,并根据优先级、日期或关键字审核日志文件。

有关更多信息,请参阅 控制面板上 Ceph 集群的过滤日志。

- 设备管理

列出 Orchestrator 已知的所有主机。列出附加到主机的所有驱动器及其属性。显示推动健康预测、SMART 数据和闪烁的 LED。

有关更多信息,请参阅 在仪表板上监控 Ceph 集群的主机。

- 查看存储集群容量

您可以在 Ceph 仪表板的 Capacity 页面中查看 Red Hat Ceph Storage 集群的原始存储容量。

有关更多信息,请参阅了解 Ceph 仪表板的登录页面。

- 池

列出和管理所有 Ceph 池及其详细信息。例如:应用程序、放置组、复制大小、EC 配置集、配额和 CRUSH 规则集。

有关更多信息,请参阅 控制面板上了解 Ceph 仪表板和 Ceph 集群的 Monitoring 池的 登录页面。

- OSD

列出和管理所有 OSD、其状态和用量统计。OSD 还列出用于读取和写入操作的详细信息,如属性、OSD map、元数据和性能计数器。OSD 也列出与 OSD 关联的所有驱动器。

有关更多信息,请参阅监控仪表板上的 Ceph OSD。

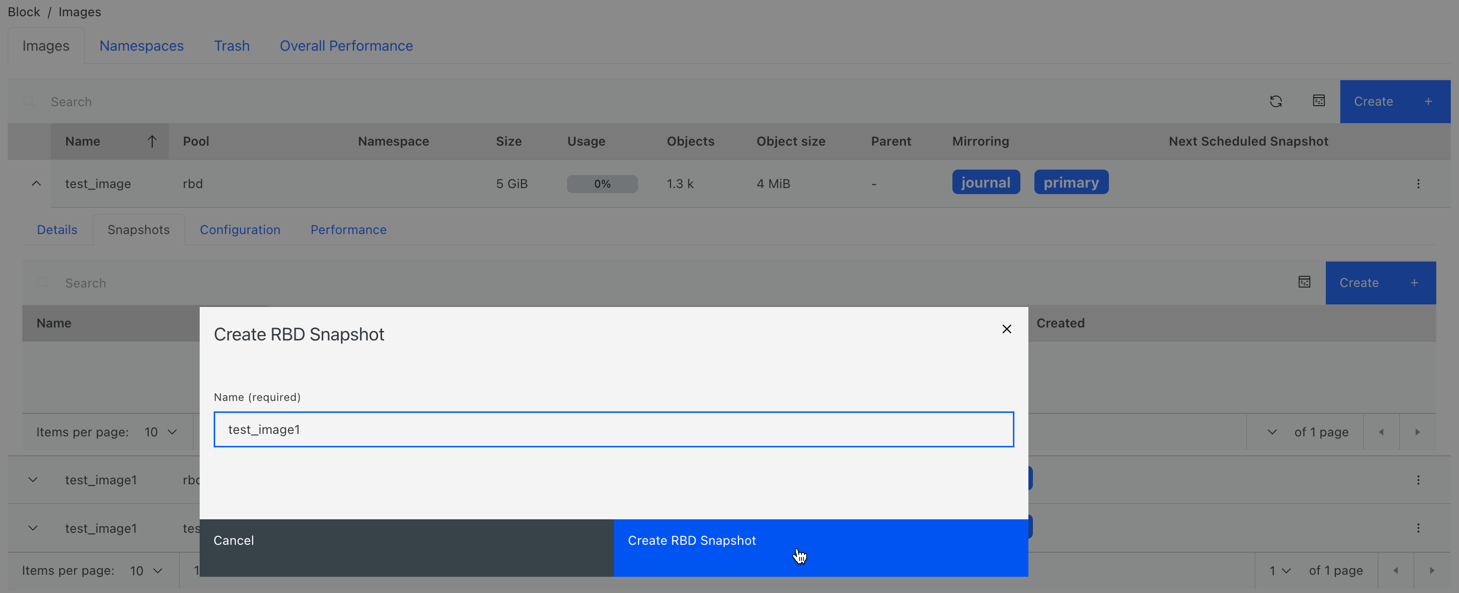

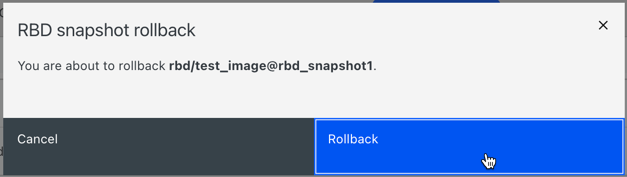

- 镜像

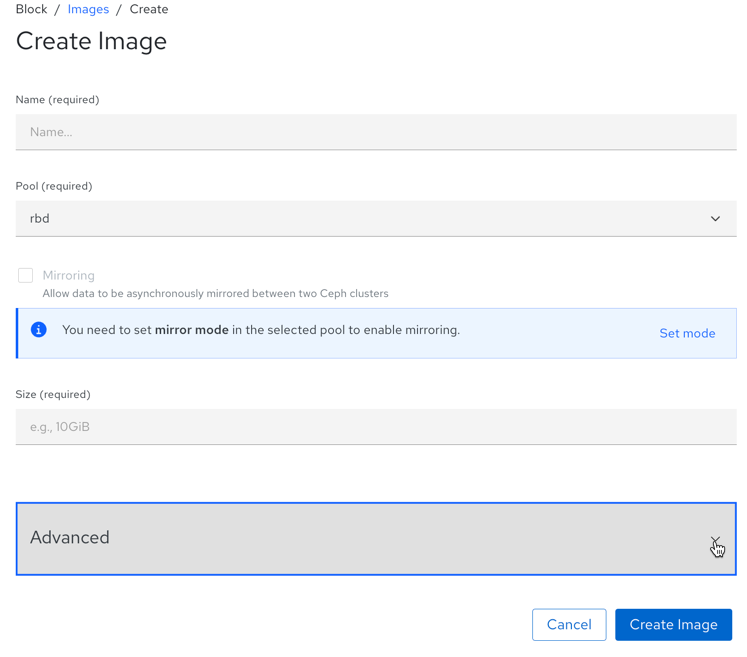

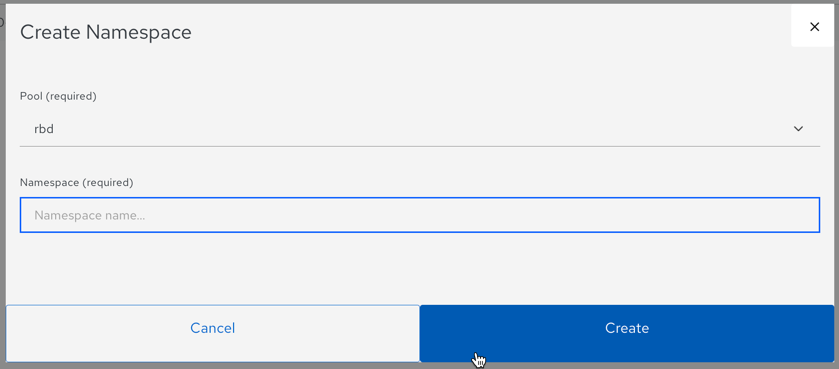

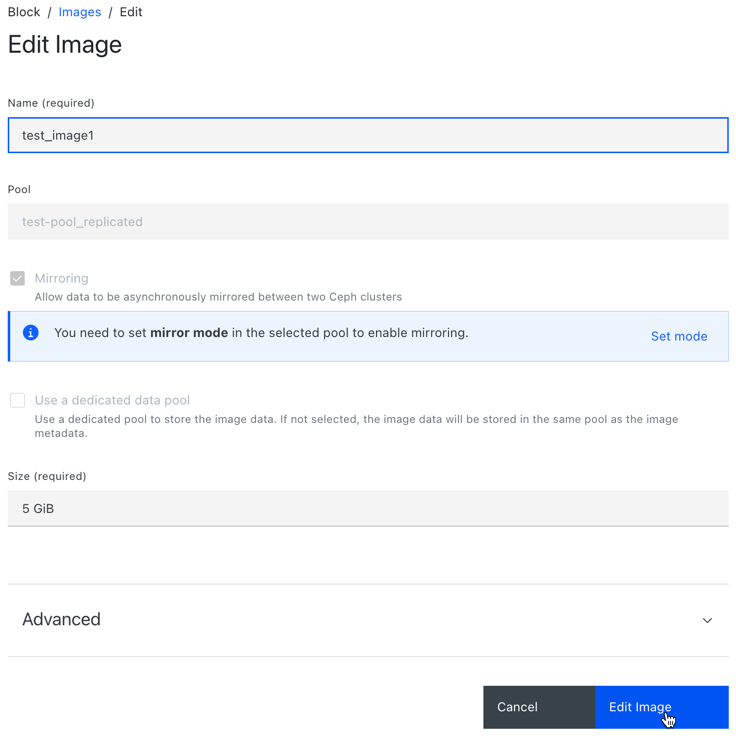

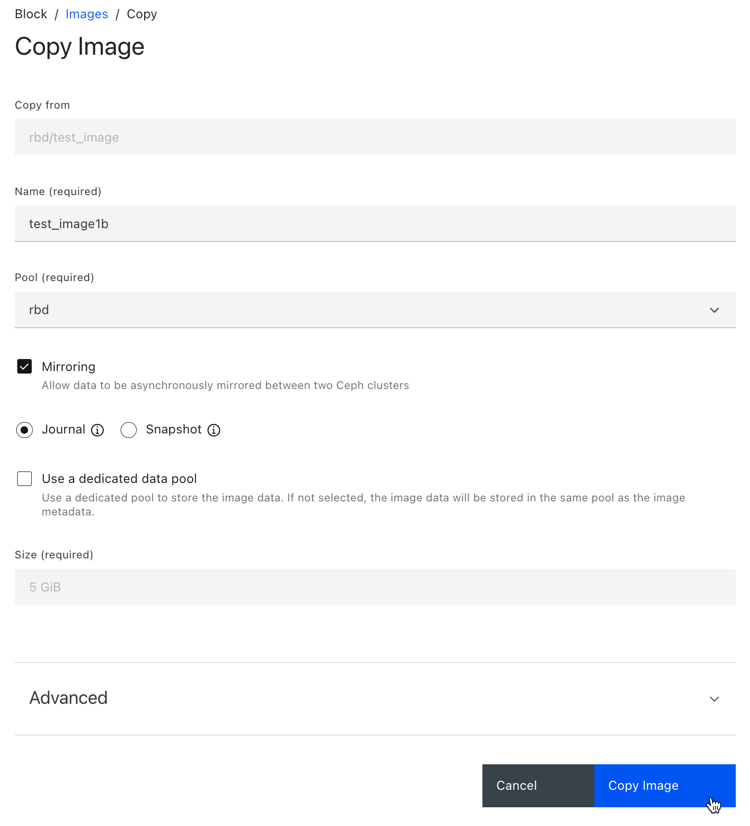

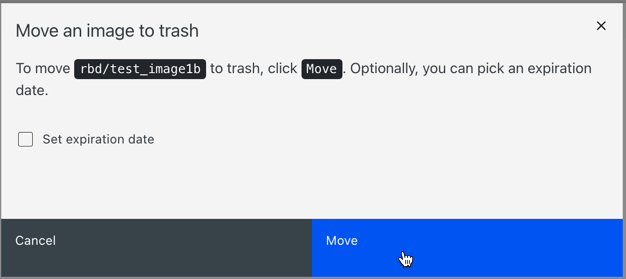

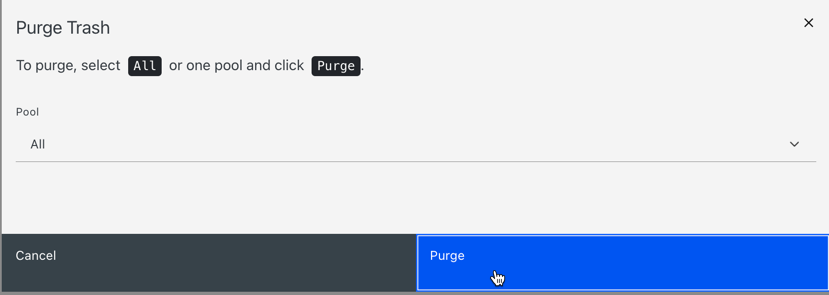

列出所有 Ceph 块设备(RBD)镜像及其属性,如大小、对象和功能。创建、复制、修改和删除 RBD 镜像。创建、删除和回滚选定镜像的快照,防止或取消保护这些快照以进行修改。复制或克隆快照,扁平化克隆的镜像。

注意特定镜像的 Overall Performance 选项卡中的 I/O 性能图仅在指定包含该镜像的池后才会显示值,方法是在 Cluster→Manager 模块→Prometheus 中设置

rbd_stats_pool参数。有关更多信息,请参阅监控 Ceph 控制面板中的块设备镜像。

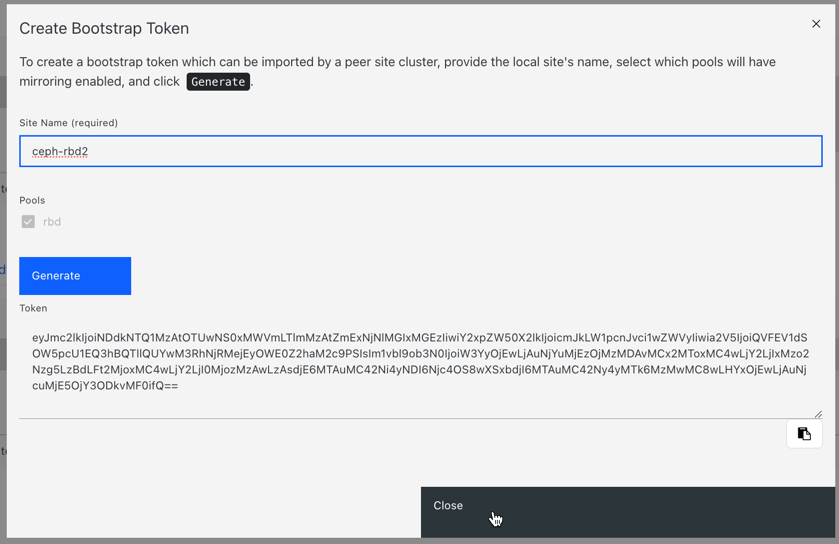

- 块设备镜像

为远程 Ceph 服务器启用并配置 Ceph 块设备(RBD)镜像。列出所有活跃同步守护进程及其状态、池和 RBD 镜像,包括它们的同步状态。

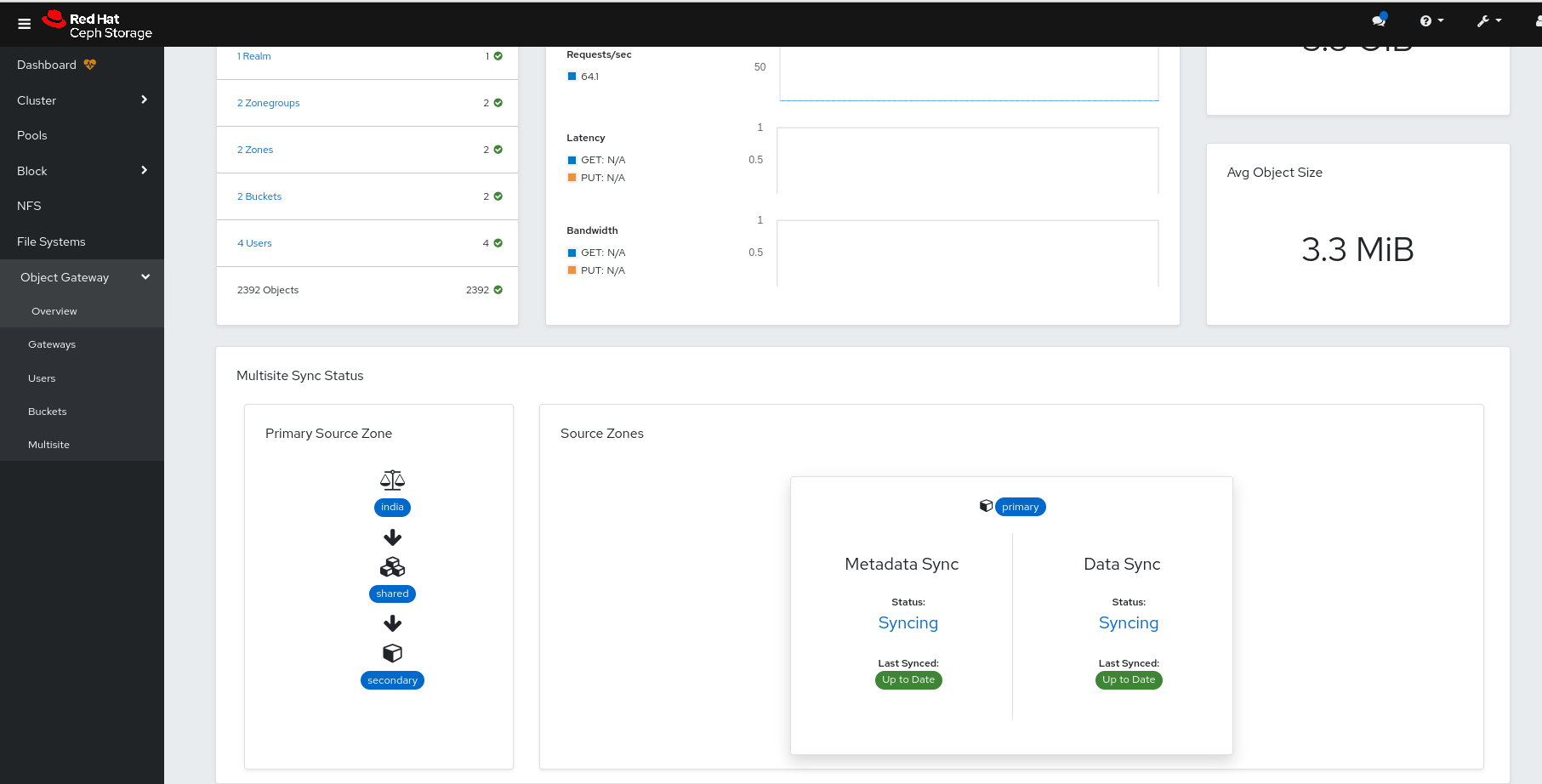

有关更多信息,请参阅 Ceph 仪表板上的镜像视图。

- Ceph 文件系统

列出所有活动的 Ceph 文件系统(CephFS)客户端和相关池,包括它们的使用量统计数据。驱除活跃的 CephFS 客户端,管理 CephFS 配额和快照,并浏览 CephFS 目录结构。

有关更多信息,请参阅 监控仪表板上的 Ceph 文件系统。

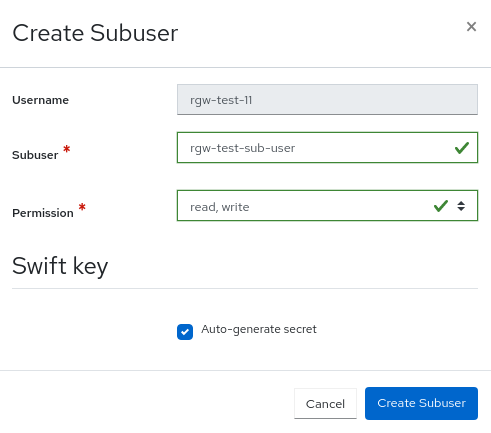

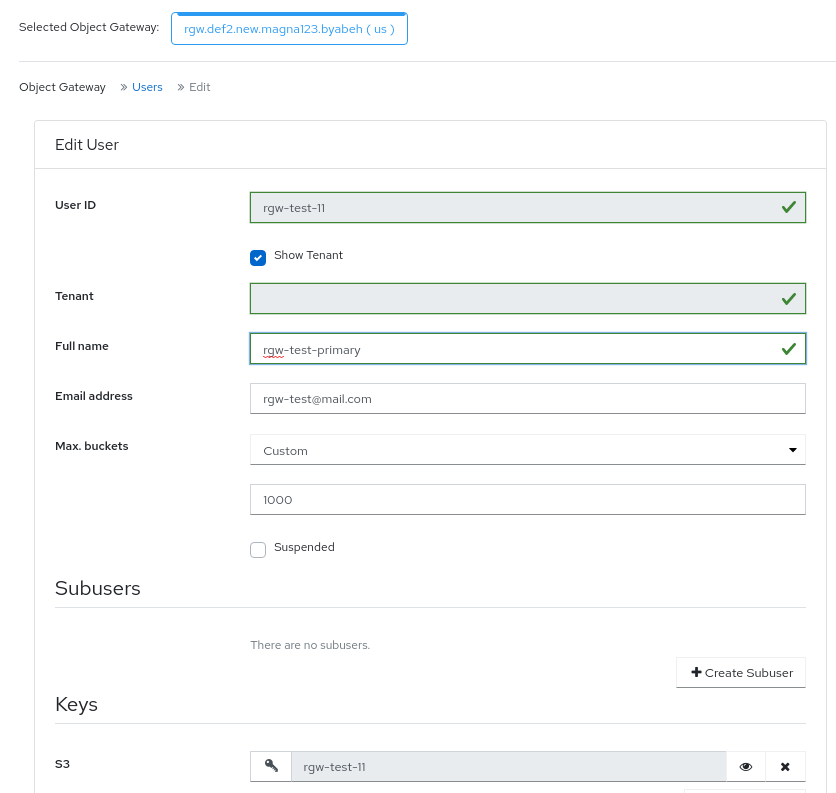

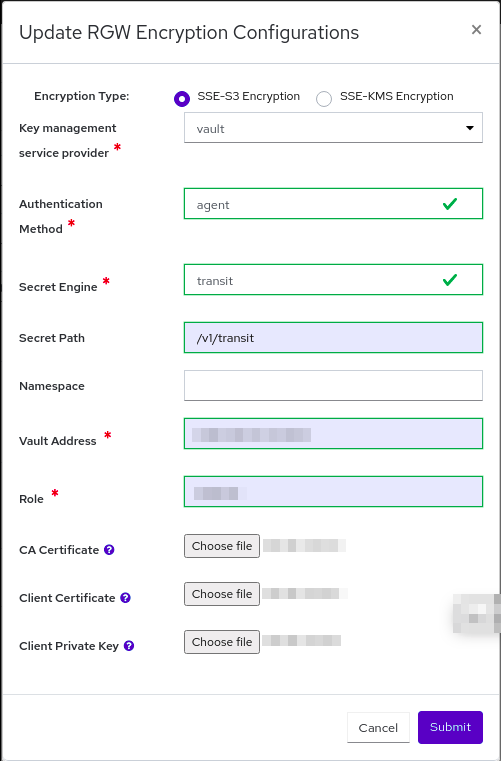

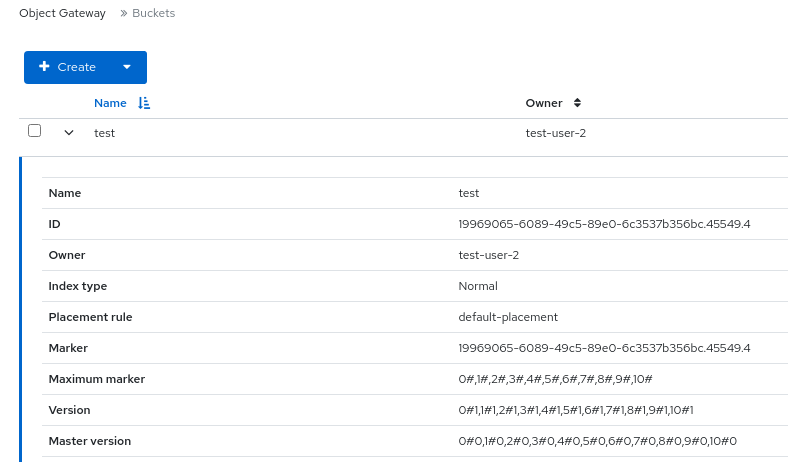

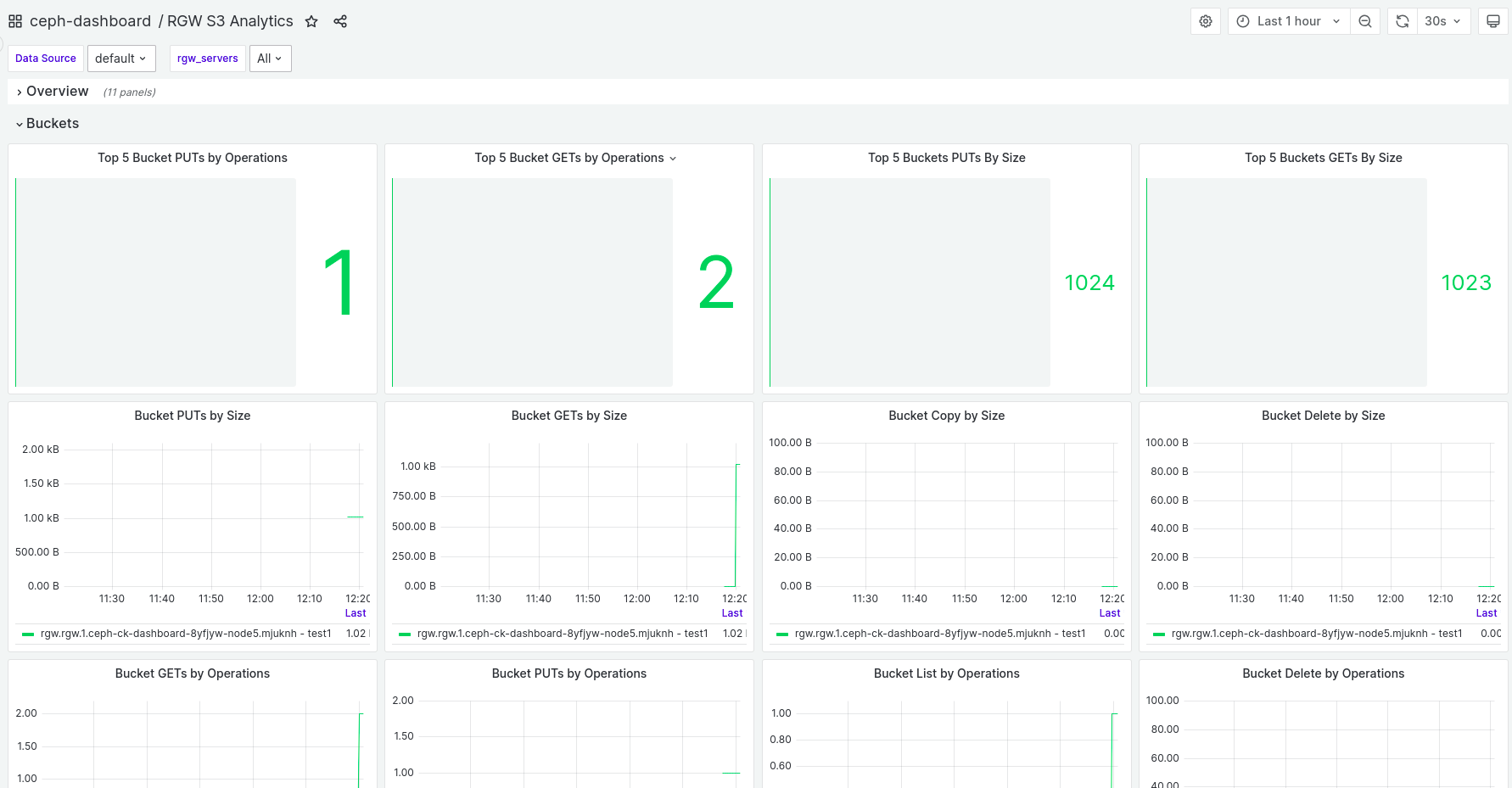

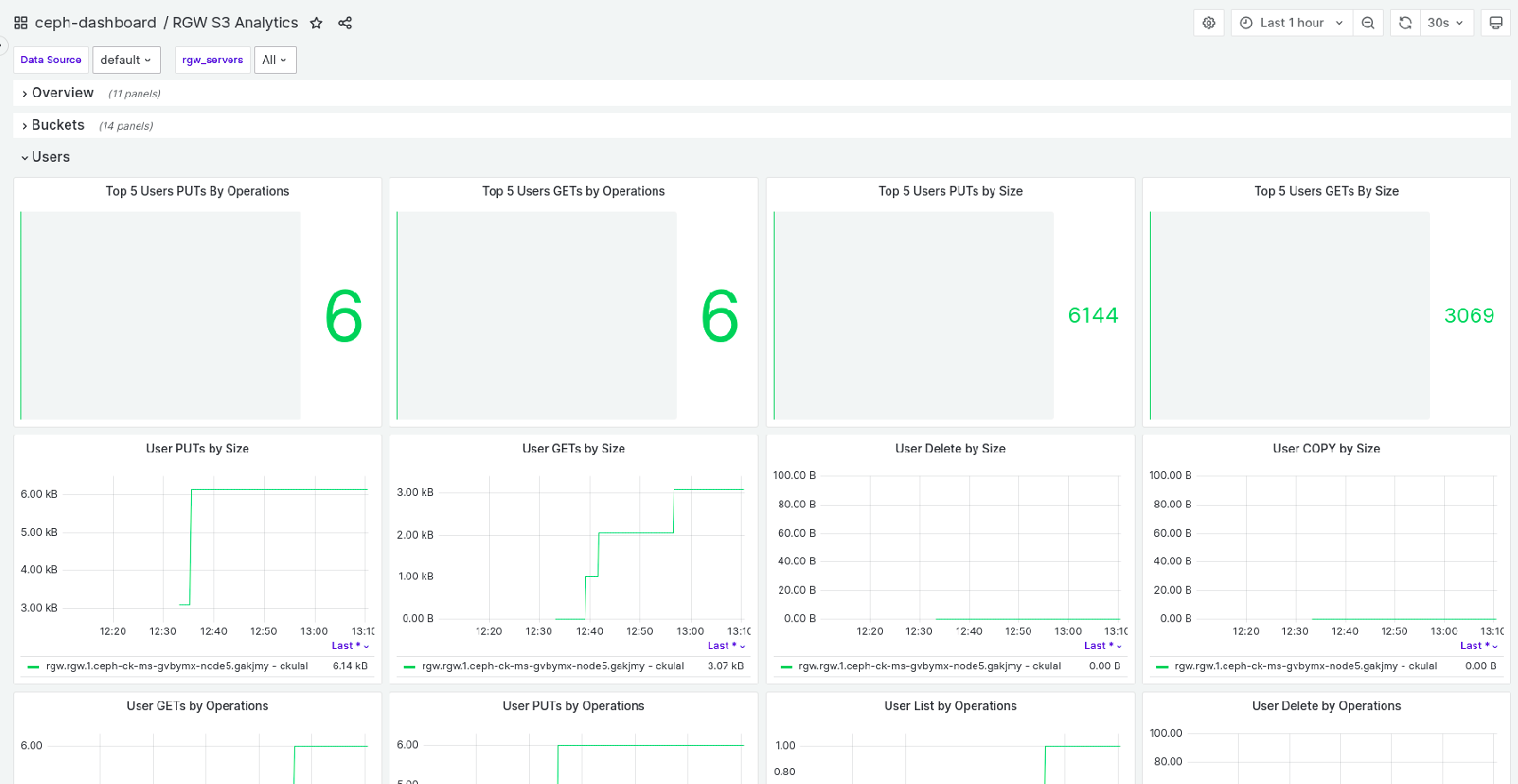

- 对象网关(RGW)

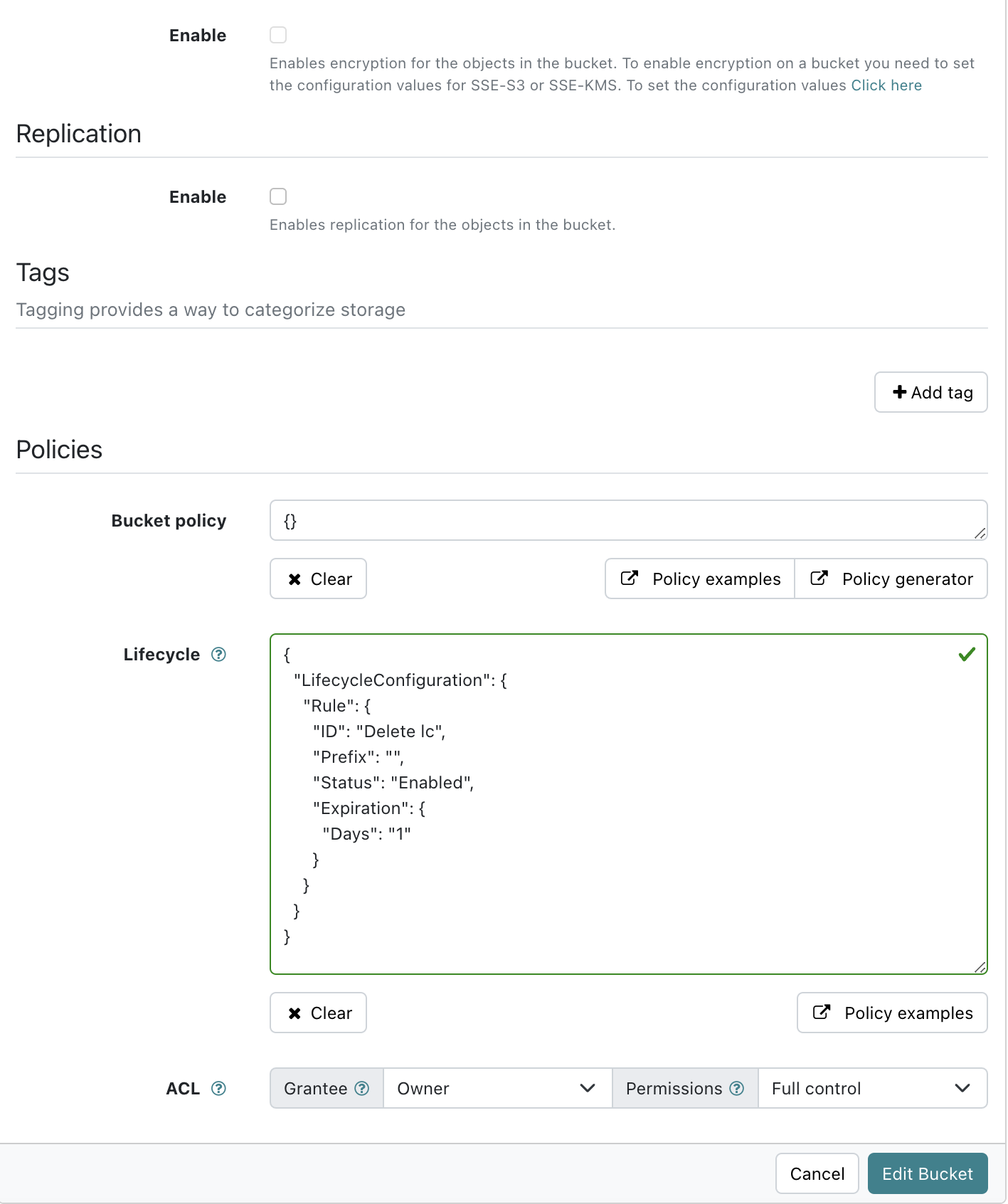

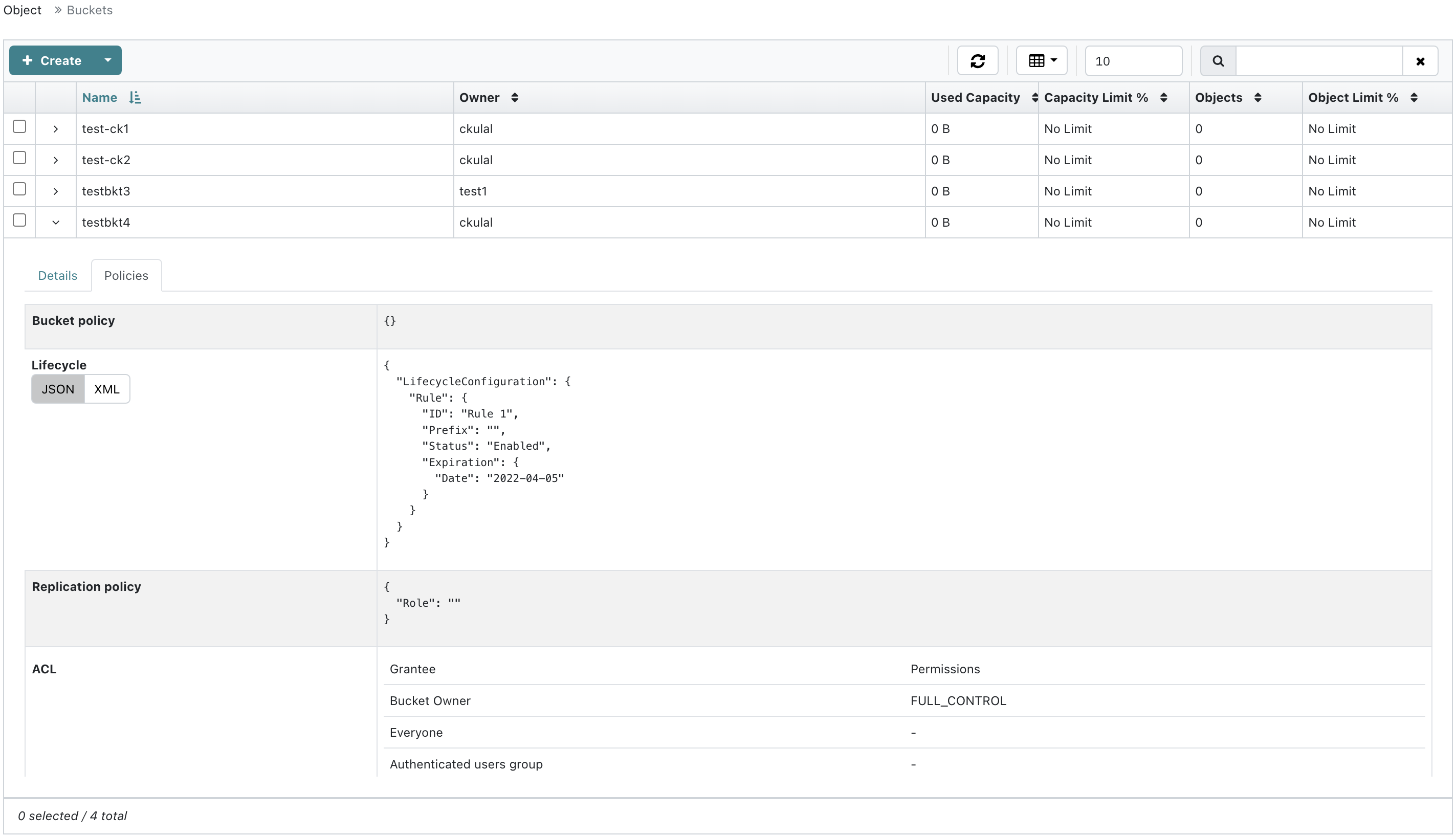

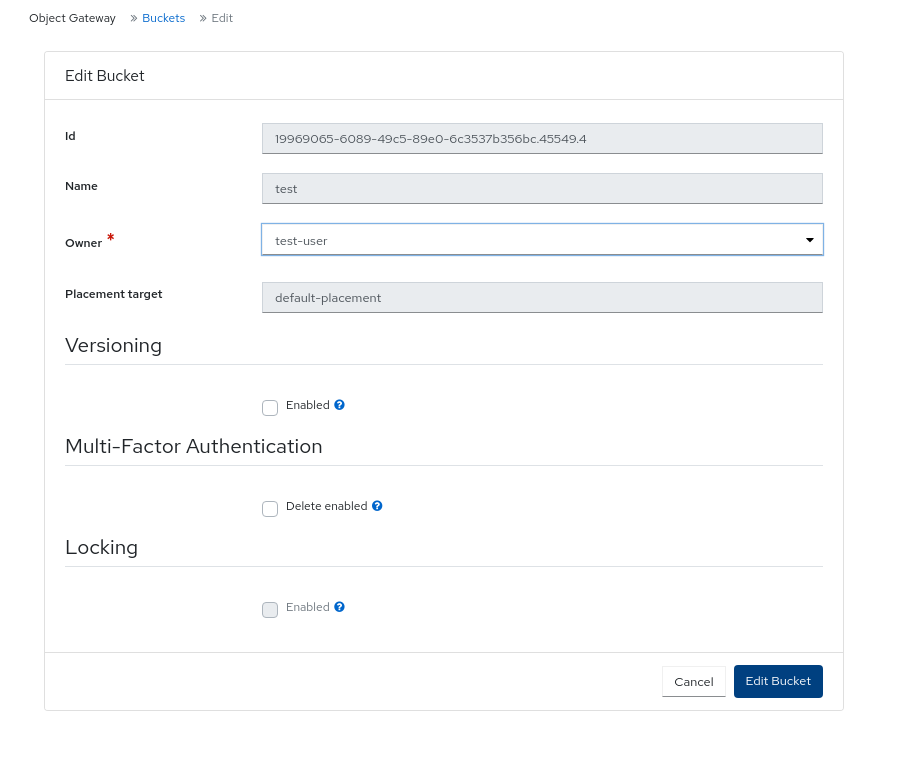

列出所有活跃的对象网关及其性能计数器。显示和管理,包括添加、编辑和删除 Ceph 对象网关用户及其详细信息,如配额,以及用户的存储桶及其详细信息,如所有者或配额。

有关更多信息,请参阅 控制面板上的监控 Ceph 对象网关守护进程。

安全功能

控制面板提供以下安全功能:

- SSL 和 TLS 支持

Web 浏览器和控制面板之间的所有 HTTP 通信均通过 SSL 保护。可以使用内置命令创建自签名证书,但也可以导入由证书颁发机构(CA)签名和发布的自定义证书。

有关更多信息,请参阅 Ceph 控制面板安装并访问。

先决条件

- 系统管理员级别体验。

1.1. Ceph Dashboard 组件

仪表板的功能由多个组件提供。

- 用于部署的 Cephadm 应用。

-

嵌入式仪表板

ceph-mgr模块。 -

嵌入的 Prometheus

ceph-mgr模块。 - Prometheus 时间序列数据库。

- Prometheus node-exporter 守护进程,在存储集群的每个主机上运行。

- 用于监控用户界面和警报的 Grafana 平台。

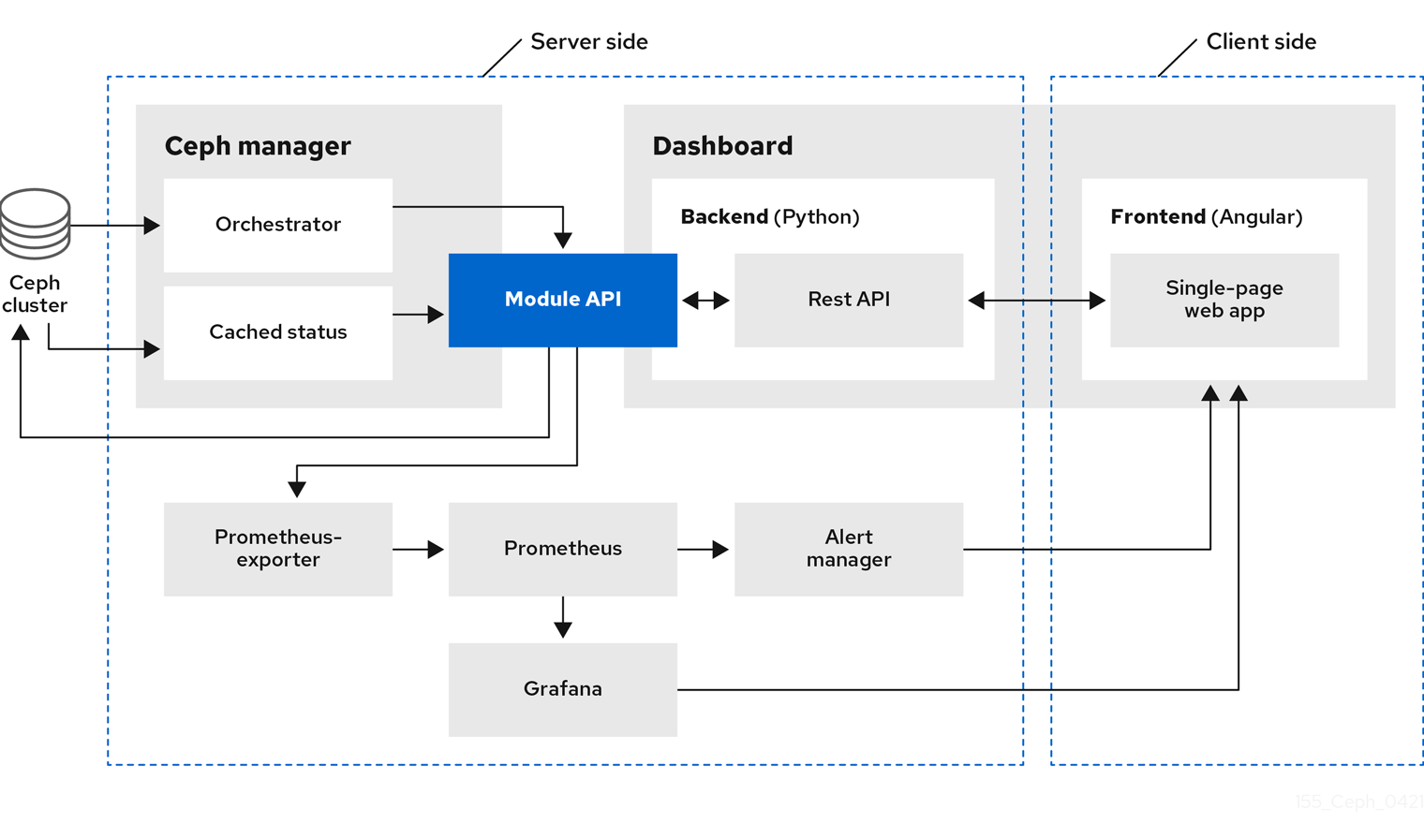

1.2. Red Hat Ceph Storage Dashboard 架构

控制面板架构依赖于 Ceph 管理器仪表板插件和其他组件。请参见以下示意图,以了解 Ceph 管理器和仪表板如何协同工作。

第 2 章 Ceph Dashboard 安装和访问

作为系统管理员,您可以使用 bootstrap 集群中提供的凭证访问仪表板。

Cephadm 默认安装控制面板。以下是仪表板 URL 的示例:

URL: https://host01:8443/ User: admin Password: zbiql951ar

URL: https://host01:8443/

User: admin

Password: zbiql951ar更新浏览器,再清除 Cookie,然后再访问仪表板 URL。

以下是可用于 Ceph 仪表板配置的 Cephadm bootstrap 选项:

- [-initial-dashboard-user INITIAL_DASHBOARD_USER] - 在 bootstrapping 设置 initial-dashboard-user 时使用这个选项。

- [-initial-dashboard-password INITIAL_DASHBOARD_PASSWORD] - 在 bootstrapping 设置 initial-dashboard-password 时使用该选项。

- [–ssl-dashboard-port SSL_DASHBOARD_PORT] - 当 bootstrap 设置自定义仪表板端口而不是默认的 8443 端口时使用这个选项。

- [-dashboard-key DASHBOARD_KEY] - 在 bootstrap 设置用于 SSL 的自定义密钥时使用这个选项。

- [–dashboard-crt DASHBOARD_CRT] - 在 bootstrap 来为 SSL 设置自定义证书时使用这个选项。

- [–skip-dashboard] - 当 bootstrap 在没有仪表板的情况下部署 Ceph 时使用这个选项。

- [–dashboard-password-noupdate] - 如果您使用了以上两个选项并不希望在第一次登陆时重置密码时,在 bootstrap 中使用这个选项。

- [-allow-fqdn-hostname] - 在 bootstrap 时使用该选项以允许完全限定的主机名。

- [-skip-prepare-host] - 在 bootstrap 时使用该选项跳过主机准备。

为了避免与仪表板相关的外部 URL 连接问题,请将完全限定域名(FQDN)用于主机名,例如 host01.ceph.redhat.com。

在客户端互联网浏览器中直接打开 Grafana URL,并接受安全例外来查看 Ceph 仪表板上的图形。重新加载浏览器以查看更改。

示例

cephadm bootstrap --mon-ip 127.0.0.1 --registry-json cephadm.txt --initial-dashboard-user admin --initial-dashboard-password zbiql951ar --dashboard-password-noupdate --allow-fqdn-hostname

[root@host01 ~]# cephadm bootstrap --mon-ip 127.0.0.1 --registry-json cephadm.txt --initial-dashboard-user admin --initial-dashboard-password zbiql951ar --dashboard-password-noupdate --allow-fqdn-hostname

在使用 cephadm 增强存储集群时,您可以使用 --image 选项用于自定义容器镜像或本地容器镜像。

只有在 bootstrap 没有使用 --dashboard-password-noupdate 选项时,您必须在第一次使用 bootstrap 时更改密码。您可以在 var/log/ceph/cephadm.log 文件中找到 Ceph 仪表板凭据。使用 "Ceph Dashboard is now available at" 字符串进行搜索。

本节涵盖以下任务:

2.1. Ceph 控制面板的网络端口要求

Ceph 仪表板组件使用某些必须可以被访问的 TCP 网络端口。默认情况下,在安装 Red Hat Ceph Storage 时,在 firewalld 中自动打开网络端口。

| 端口 | 使用 | 原始主机 | 目的地主机 |

|---|---|---|---|

| 8443 | 仪表板 Web 界面 | 需要访问 Grafana 服务器上的 Ceph Dashboard UI 和主机的 IP 地址,因为 AlertManager 服务也可以启动到 Dashboard 的连接以报告警报。 | Ceph 管理器主机。 |

| 3000 | Grafana | 需要访问 Grafana 仪表板 UI 和所有 Ceph Manager 主机和 Grafana 服务器的 IP 地址。 | 运行 Grafana 服务器的主机。 |

| 2049 | NFS-Ganesha | 需要访问 NFS 的 IP 地址。 | 提供 NFS 服务的 IP 地址。 |

| 9095 | 基本 Prometheus 图形的默认 Prometheus 服务器 | 需要访问 Prometheus UI 以及运行 Prometheus 的所有 Ceph Manager 主机和 Grafana 服务器或主机的 IP 地址。 | 运行 Prometheus 的主机或主机。 |

| 9093 | Prometheus Alertmanager | 需要访问 Alertmanager Web UI 以及运行 Prometheus 的所有 Ceph Manager 主机和 Grafana 服务器或主机的 IP 地址。 | Grafana 服务器下所有 Ceph Manager 主机。 |

| 9094 | Prometheus Alertmanager 可配置从多个实例组成的高可用性集群 | Grafana 服务器下所有 Ceph Manager 主机。 |

Prometheus Alertmanager High Availability(对等点守护进程同步),因此 |

| 9100 |

Prometheus | 运行 Prometheus 的主机需要查看节点导出器指标 Web UI 以及运行 Prometheus 的所有 Ceph Manager 主机和 Grafana 服务器或主机。 | 所有存储集群主机,包括 MON、OSDS、Grafana 服务器主机。 |

| 9283 | Ceph Manager Prometheus exporter 模块 | 运行 Prometheus 的主机需要访问 Ceph 导出器 metrics Web UI 和 Grafana 服务器。 | 所有 Ceph Manager 主机。 |

2.2. 访问 Ceph 仪表板

您可以访问 Ceph 仪表板来管理和监控 Red Hat Ceph Storage 集群。

先决条件

- 成功安装 Red Hat Ceph Storage 仪表板。

- NTP 正在正确同步时钟。

流程

在网页浏览器中输入以下 URL:

语法

https://HOST_NAME:PORT

https://HOST_NAME:PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 替换:

- 带有活跃管理器主机的完全限定域名(FQDN)的 HOST_NAME。

PORT 带有端口

8443示例

https://host01:8443

https://host01:8443Copy to Clipboard Copied! Toggle word wrap Toggle overflow 您也可以在 Cephadm shell 中运行以下命令获取仪表板的 URL:

示例

[ceph: root@host01 /]# ceph mgr services

[ceph: root@host01 /]# ceph mgr servicesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 此命令将显示当前配置的所有端点。查找

dashboard键,以获取用于访问仪表板的 URL。

-

在登录页面中,输入用户名

admin和 bootstrap 中提供的默认密码。 - 首次登录 Red Hat Ceph Storage 仪表板时,您必须更改密码。

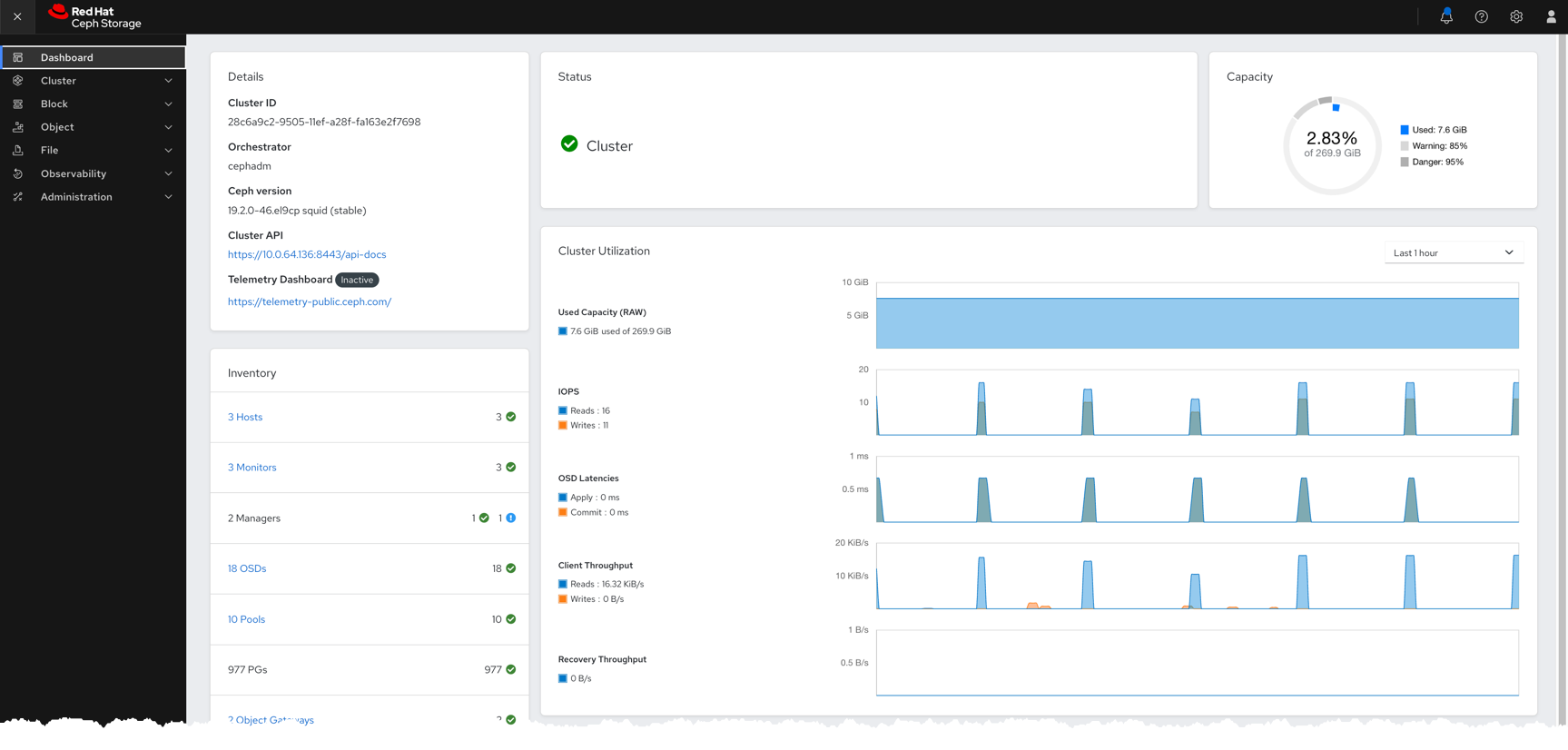

登录后,会显示仪表板默认登录页面,其中提供了 Red Hat Ceph Storage 集群的状态、性能、清单和容量指标的详细信息。

图 2.1. Ceph 仪表板登录页面

-

点仪表板页面中的菜单图标(

)折叠或显示垂直菜单中的选项。

)折叠或显示垂直菜单中的选项。

2.3. 在 Ceph 仪表板中扩展集群

您可以使用仪表板来扩展 Red Hat Ceph Storage 集群,以添加主机、添加 OSD 和创建服务,如 Alertmanager、Cephadm-exporter、CephFS-mirror、Grafana、ingress、MDS、NFS、node-exporter、Prometheus、RBD-mirror 和 Ceph 对象网关。

引导新的存储集群后,会创建 Ceph Monitor 和 Ceph Manager 守护进程,集群处于 HEALTH_WARN 状态。在仪表板上创建集群的所有服务后,集群的健康状况从 HEALTH_WARN 更改为 HEALTH_OK 状态。

先决条件

- 启动的存储集群。如需了解更多详细信息 ,请参阅 Red Hat Ceph Storage 安装指南中的 引导 新存储集群部分。

-

在 Red Hat Ceph Storage 仪表板中,用户至少为

cluster-manager角色。如需了解更多详细信息,请参阅 Red Hat Ceph Storage 仪表板指南中的 Ceph仪表板上的用户角色和权限 部分。

流程

将 Bootstrapped 主机中的 admin 密钥复制到其他主机:

语法

ssh-copy-id -f -i /etc/ceph/ceph.pub root@HOST_NAME

ssh-copy-id -f -i /etc/ceph/ceph.pub root@HOST_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ssh-copy-id -f -i /etc/ceph/ceph.pub root@host02 [ceph: root@host01 /]# ssh-copy-id -f -i /etc/ceph/ceph.pub root@host03

[ceph: root@host01 /]# ssh-copy-id -f -i /etc/ceph/ceph.pub root@host02 [ceph: root@host01 /]# ssh-copy-id -f -i /etc/ceph/ceph.pub root@host03Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 使用 bootstrap 过程中提供的默认凭证登录到控制面板。

- 更改密码,再使用新密码登录控制到仪表板。

在登录页面上,单击 Expand Cluster。

注意点 Expand Cluster 可打开向导,执行扩展步骤。要单独跳过并添加主机和服务,请点 跳过。

图 2.2. 展开集群

添加主机。这需要针对存储集群中的每个主机完成。

- 在 Add Hosts 步骤中,单击 Add。

提供主机名。这与从 bootstrapped 主机复制密钥时提供的主机名相同。

注意使用以逗号分隔的主机名、范围表达式或逗号分隔的范围表达式列表来添加多个主机。

- 可选:提供主机的对应 IP 地址。

- 可选:选择将要创建服务的主机的标签。点击铅笔图标选择或添加新标签。

单击 Add Host。

新主机显示在 Add Hosts 窗格中。

- 点击 Next。

创建 OSD:

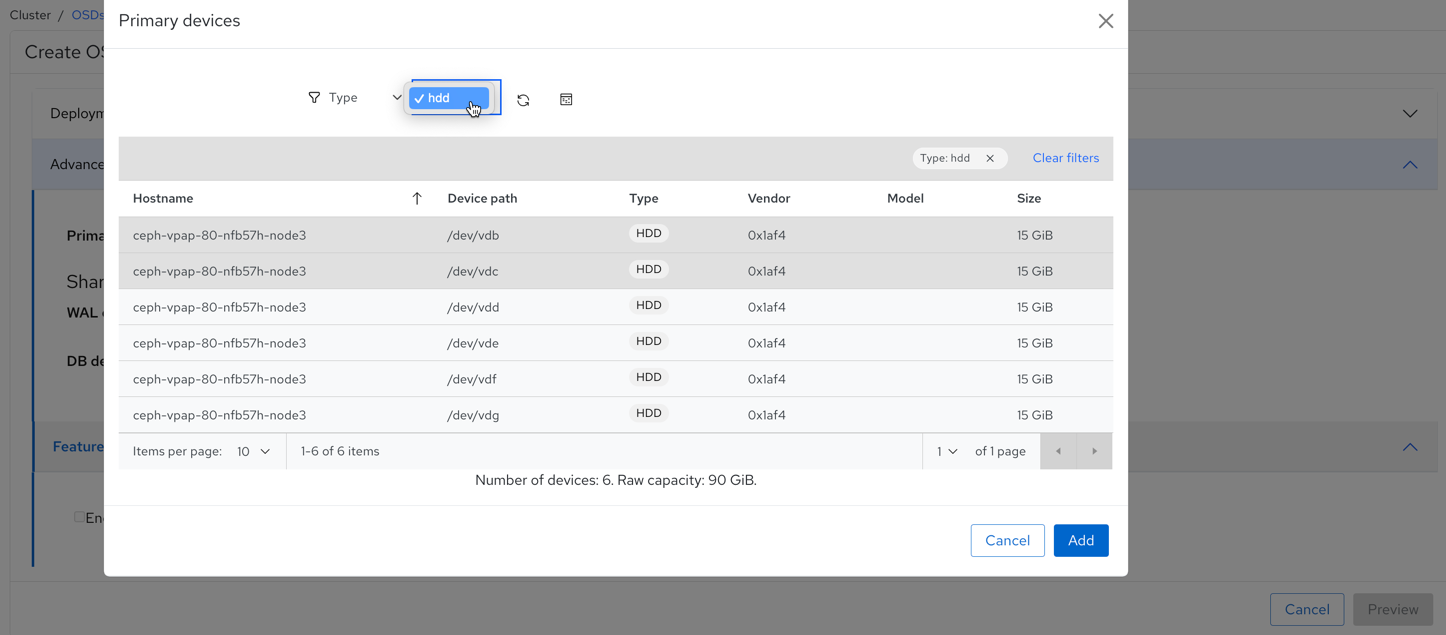

- 在 Create OSD 步骤中,对于主设备,单击 Add。

- 在 主设备 窗口中,过滤该设备并选择设备。

- 点击 Add。

- 可选:在 Create OSD 窗口中,如果您有任何共享设备,如 WAL 或 DB 设备,则添加设备。

- 可选:在 Features 部分中,选择 Encryption 来加密功能。

- 点击 Next。

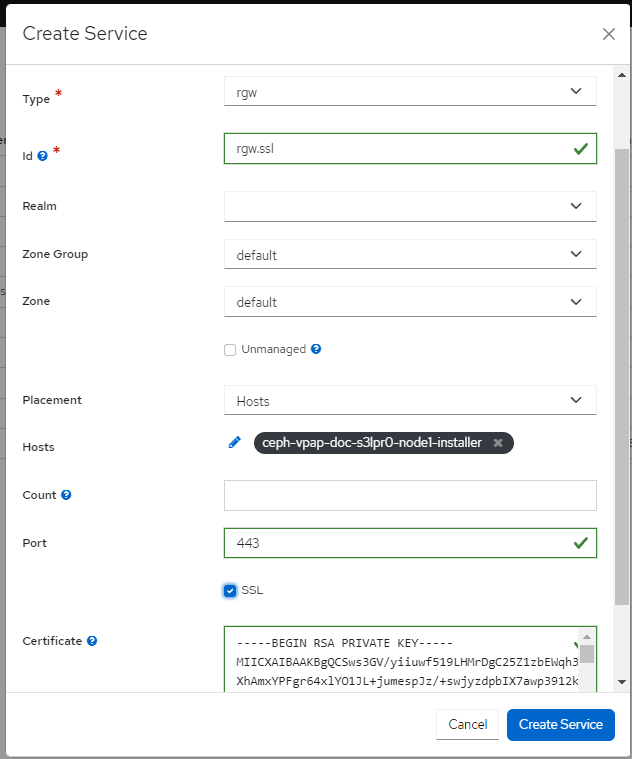

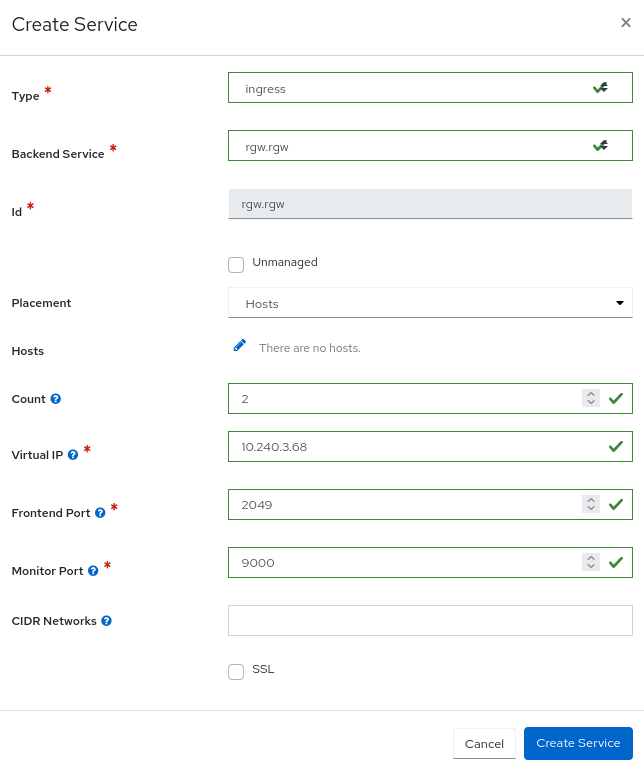

创建服务:

- 在 Create Services 步骤中,单击 Create。

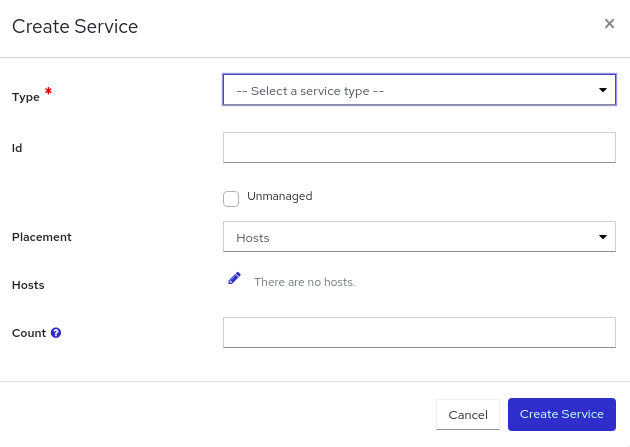

在 Create Service 表单中:

- 选择服务类型。

-

提供服务 ID。ID 是该服务的唯一名称。此 ID 在服务名称中使用,即

service_type.service_id。

…可选:如果服务是 Unmanaged,则选择该选项。

+ 选择 Unmanaged 服务时,编配器不会启动或停止与此服务关联的任何守护进程。放置和所有其他属性都会被忽略。

- 选择放置是否由主机或标签选择。

- 选择主机。

在 Count 字段中,提供需要部署的守护进程或服务数量。

点 Create Service。

新服务显示在 Create Services 窗格中。

- 在 Create Service 窗口中,单击 Next。

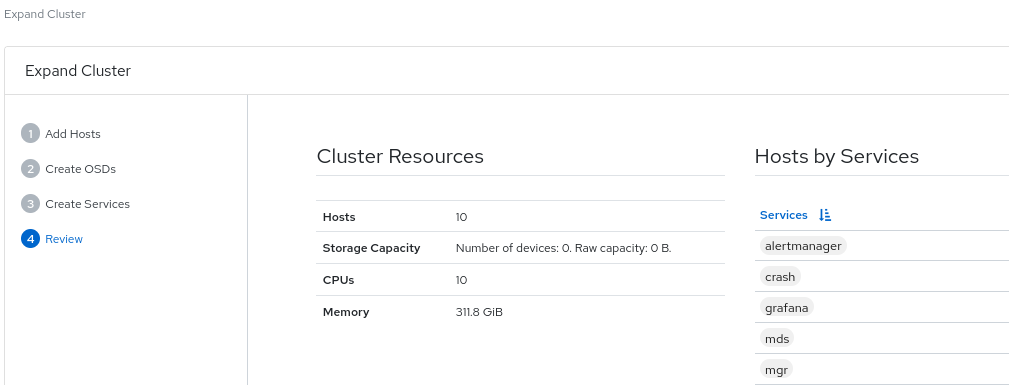

查看集群扩展详情。

查看 Cluster Resources,即服务主机、主机详情。要编辑任何参数,请点击 Back 并按照前面的步骤操作。

图 2.3. 查看集群

单击 Expand Cluster。

此时会显示

Cluster expansion displayed通知,集群状态在仪表板上更改为 HEALTH_OK。

验证

登录到

cephadmshell:示例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行

ceph -s命令。示例

[ceph: root@host01 /]# ceph -s

[ceph: root@host01 /]# ceph -sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 集群的运行状况是 HEALTH_OK。

2.4. 升级集群

使用控制面板升级 Ceph 集群。

集群镜像从 registry.redhat.io 自动拉取。另外,还可使用自定义镜像进行升级。

先决条件

在开始升级过程前,请验证您的升级路径和操作系统是否被支持。有关更多信息,请参阅 Red Hat Ceph Storage 8.0 的兼容性列表。

在开始前,请确保您有以下先决条件:

这些项目无法通过仪表板完成,且必须通过命令行界面手动完成,然后才能从仪表板升级集群。

如需更多信息,请参阅 在断开连接的环境中升级 Red Hat Ceph Storage 集群,并完成第 1 步。

最新的

cephadm。语法

dnf udpate cephadm

dnf udpate cephadmCopy to Clipboard Copied! Toggle word wrap Toggle overflow 最新的

cephadm-ansible。语法

dnf udpate cephadm-ansible

dnf udpate cephadm-ansibleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 最新的

cephadm pre-flight playbook。语法

ansible-playbook -i INVENTORY_FILE cephadm-preflight.yml --extra-vars "ceph_origin=custom upgrade_ceph_packages=true"

ansible-playbook -i INVENTORY_FILE cephadm-preflight.yml --extra-vars "ceph_origin=custom upgrade_ceph_packages=true"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下 Ceph 命令,以避免在集群升级过程中警报和重新平衡数据:

语法

ceph health mute DAEMON_OLD_VERSION --sticky ceph osd set noout ceph osd set noscrub ceph osd set nodeep-scrub

ceph health mute DAEMON_OLD_VERSION --sticky ceph osd set noout ceph osd set noscrub ceph osd set nodeep-scrubCopy to Clipboard Copied! Toggle word wrap Toggle overflow

流程

查看是否有集群升级可用,并根据需要在仪表板上的 Administration > Upgrade 中进行升级。

注意如果仪表板显示

Not retrieve upgrade消息,请检查 registry 是否已添加到容器配置文件中,并将凭据添加到 Podman 或 docker 中。如果需要,在升级过程中点 Pause 或 Stop。升级进度会在进度栏中显示,以及升级过程中的信息。

注意停止升级时,升级会首先暂停,然后提示您停止升级。

- 可选。从 Upgrade 页面的 Cluster logs 部分,在升级过程中查看集群日志。

- 确认集群状态显示 OK 状态,验证升级是否已成功完成。

验证升级完成后,取消设置

noout、noscrub和nodeep-scrub标志。示例

[ceph: root@host01 /]# ceph osd unset noout [ceph: root@host01 /]# ceph osd unset noscrub [ceph: root@host01 /]# ceph osd unset nodeep-scrub

[ceph: root@host01 /]# ceph osd unset noout [ceph: root@host01 /]# ceph osd unset noscrub [ceph: root@host01 /]# ceph osd unset nodeep-scrubCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5. 切换 Ceph 仪表板功能

您可以通过根据需要启用或禁用功能来自定义 Red Hat Ceph Storage 仪表板组件。所有功能都会默认启用。当禁用某个功能时,web-interface 元素会变为隐藏的,相关的 REST API 端点会拒绝该功能的任何进一步请求。启用和禁用仪表板功能可以通过命令行界面或 Web 界面完成。

可用功能:

Ceph 块设备:

-

镜像管理,

rbd -

镜像,

mirroring

-

镜像管理,

-

Ceph 文件系统,

cephfs -

Ceph 对象网关,

rgw -

NFS Ganesha 网关

nfs

默认情况下,Ceph Manager 与 Ceph 监控器共存。

您可以一次性禁用多个功能。

禁用某个功能后,可能需要 20 秒来反映 web 界面中的更改。

先决条件

- 安装并配置 Red Hat Ceph Storage 仪表板软件。

- 用户访问 Ceph Manager 主机或控制面板 Web 界面。

- 对 Ceph Manager 主机的 root 级别访问权限。

流程

从仪表板 web 界面中切换仪表板功能:

- 在仪表板登录页面中,进入 Administration→Manager Modules 并选择 dashboard 模块。

- 点 Edit。

- 在 Edit Manager 模块 表单中,您可以通过选择或清除不同功能名称旁边的复选框来启用或禁用仪表板功能。

- 进行选择后,单击 更新。

使用命令行界面切换仪表板功能:

登录到 Cephadm shell:

示例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow 列出功能状态:

示例

[ceph: root@host01 /]# ceph dashboard feature status

[ceph: root@host01 /]# ceph dashboard feature statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow 禁用一个功能:

[ceph: root@host01 /]# ceph dashboard feature disable rgw

[ceph: root@host01 /]# ceph dashboard feature disable rgwCopy to Clipboard Copied! Toggle word wrap Toggle overflow 本例禁用 Ceph 对象网关功能。

启用一个功能:

[ceph: root@host01 /]# ceph dashboard feature enable cephfs

[ceph: root@host01 /]# ceph dashboard feature enable cephfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 这个示例启用了 Ceph Filesystem 功能。

2.6. 了解 Ceph 仪表板的登录页面

登录页面通过导航栏和单个面板显示整个 Ceph 集群的概述。

菜单栏中提供以下选项:

- 任务和通知

- 提供任务和通知消息。

- Help

- 提供 product 和 REST API 文档的链接、有关 Red Hat Ceph Storage 仪表板的详细信息,以及用于报告问题的格式。

- 仪表板设置

- 提供对用户管理和遥测配置的访问权限。

- 用户

- 使用此菜单查看登录状态、更改密码和注销仪表板。

图 2.4. 菜单栏中

导航菜单可以通过单击导航菜单图标

来打开或隐藏。

来打开或隐藏。

Dashboard

主仪表板显示有关集群状态的特定信息。

可以从导航菜单中点 Dashboard 随时访问主仪表板。

仪表板登录页面将窗格组织到不同的类别。

图 2.5. Ceph 仪表板登录页面

- 详情

- 显示特定的集群信息,如果遥测活跃或不活跃。

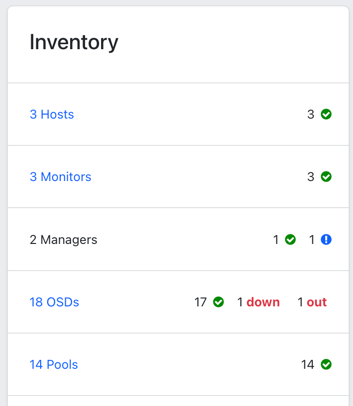

- 清单(Inventory)

显示集群的不同部分、可用数量及其状态。

直接从 清单 链接到特定清单项目,其中可用。

- 主机

- 显示 Ceph 存储集群中的主机总数。

- Monitors

- 显示 Ceph 监控器和仲裁状态的数量。

- managers

- 显示管理器守护进程的数量和状态。

- OSD

- 显示 Ceph Storage 集群中的 OSD 总数,以及 中启动的数量、和 的数量。

- 池

- 显示 Ceph 集群中的存储池数量。

- PGs

显示放置组(PG)的总数。PG 状态划分为 Working 和 Warning,以简化显示。各自包含多个状态。+ 工作状态包括具有以下状态的 PG:

- 激活

- backfill_wait

- 回填

- 创建

- deep

- degraded

- forced_backfill

- forced_recovery

- peering

- peered

- recovering

- recovery_wait

- repair

- 清理

- snaptrim

- snaptrim_wait + Warning 状态包含具有以下状态的 PG:

- backfill_toofull

- backfill_unfound

- down

- incomplete

- 不一致

- recovery_toofull

- recovery_unfound

- remapped

- snaptrim_error

- stale

- undersized

- 对象网关

- 显示 Ceph 存储集群中对象网关的数量。

- 元数据服务器

- 显示 Ceph 文件系统(CephFS)的元数据服务器的数量和状态。

- Status

- 显示集群和主机和守护进程状态的健康状态。此时会显示 Ceph 存储集群的当前健康状况。danger 和 warning 警报直接显示在登录页面中。单击 View alerts 以获取完整的警报列表。

- 容量

- 显示存储使用指标。这显示为已用、warning 和 danger 的图表。数字以百分比表示,以 GiB 为单位。

- Cluster Utilization

- Cluster Utilization 窗格显示与数据传输速度相关的信息。从列表中选择数据输出的时间范围。选择最后 5 分钟到最后 24 小时之间的范围。

- 使用的容量(RAW)

- 显示 GiB 中的使用量。

- IOPS

- 显示每秒 I/O 读写操作总数。

- OSD 冲突

- 显示每毫秒应用和提交总数。

- 客户端吞吐量

- 以每秒 KiB 为单位显示总客户端读取和写入吞吐量。

- 恢复吞吐量

- 显示集群修复和平衡操作的速度。例如,显示由于磁盘丢失而可能移动的后台数据的状态。该信息以字节/秒为单位。

2.7. 使用 Ceph 仪表板更改仪表板密码

默认情况下,用于访问仪表板的密码在引导集群时由系统随机生成。首次登录 Red Hat Ceph Storage 仪表板时,您必须更改密码。您可以使用控制面板更改 admin 用户的密码。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

流程

登录到仪表板:

语法

https://HOST_NAME:8443

https://HOST_NAME:8443Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 进入菜单栏中的 User→Change 密码。

- 输入旧密码进行验证。

- 在 New password 字段中,输入新密码。密码必须包含最少 8 个字符,且不能与最后一个字符相同。

- 在 Confirm password 字段中,再次输入新密码以确认。

单击 "更改密码 "。

您将退出并重定向到登录屏幕。此时会出现确认密码的通知。

2.8. 使用命令行界面更改 Ceph 仪表板密码

如果您忘记了 Ceph 仪表板密码,您可以使用命令行界面更改密码。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 安装了仪表板的主机的根级别访问。

流程

登录到 Cephadm shell:

示例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建

dashboard_password.yml文件:示例

[ceph: root@host01 /]# touch dashboard_password.yml

[ceph: root@host01 /]# touch dashboard_password.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 编辑该文件并添加新仪表板密码:

示例

[ceph: root@host01 /]# vi dashboard_password.yml

[ceph: root@host01 /]# vi dashboard_password.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重置仪表板密码:

语法

ceph dashboard ac-user-set-password DASHBOARD_USERNAME -i PASSWORD_FILE

ceph dashboard ac-user-set-password DASHBOARD_USERNAME -i PASSWORD_FILECopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph dashboard ac-user-set-password admin -i dashboard_password.yml {"username": "admin", "password": "$2b$12$i5RmvN1PolR61Fay0mPgt.GDpcga1QpYsaHUbJfoqaHd1rfFFx7XS", "roles": ["administrator"], "name": null, "email": null, "lastUpdate": , "enabled": true, "pwdExpirationDate": null, "pwdUpdateRequired": false}[ceph: root@host01 /]# ceph dashboard ac-user-set-password admin -i dashboard_password.yml {"username": "admin", "password": "$2b$12$i5RmvN1PolR61Fay0mPgt.GDpcga1QpYsaHUbJfoqaHd1rfFFx7XS", "roles": ["administrator"], "name": null, "email": null, "lastUpdate": , "enabled": true, "pwdExpirationDate": null, "pwdUpdateRequired": false}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

- 使用新密码登录控制面板。

2.9. 为 Grafana 设置 admin 用户密码

默认情况下,cephadm 不会为 Grafana 创建管理员用户。使用 Ceph 编排器,您可以创建 admin 用户并设置密码。

使用这些凭证,您可以使用 admin 用户提供的密码登录到存储集群的 Grafana URL。

先决条件

- 安装了监控堆栈的 Red Hat Ceph Storage 集群。

-

cephadm主机的 root 级别访问权限。 -

启用

dashboard模块。

流程

作为 root 用户,创建一个

grafana.yml文件并提供以下详情:语法

service_type: grafana spec: initial_admin_password: PASSWORD

service_type: grafana spec: initial_admin_password: PASSWORDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

service_type: grafana spec: initial_admin_password: mypassword

service_type: grafana spec: initial_admin_password: mypasswordCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将

grafana.yml文件挂载到容器的一个目录中:示例

cephadm shell --mount grafana.yml:/var/lib/ceph/grafana.yml

[root@host01 ~]# cephadm shell --mount grafana.yml:/var/lib/ceph/grafana.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意每次退出 shell 时,您都必须在部署守护进程前将该文件挂载到容器中。

可选:检查是否启用了

dashboardCeph Manager 模块:示例

[ceph: root@host01 /]# ceph mgr module ls

[ceph: root@host01 /]# ceph mgr module lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:启用

dashboardCeph Manager 模块:示例

[ceph: root@host01 /]# ceph mgr module enable dashboard

[ceph: root@host01 /]# ceph mgr module enable dashboardCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

orch命令应用规格:语法

ceph orch apply -i FILE_NAME.yml

ceph orch apply -i FILE_NAME.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph orch apply -i /var/lib/ceph/grafana.yml

[ceph: root@host01 /]# ceph orch apply -i /var/lib/ceph/grafana.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重新部署

grafana服务:示例

[ceph: root@host01 /]# ceph orch redeploy grafana

[ceph: root@host01 /]# ceph orch redeploy grafanaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 这会创建一个名为

admin的 admin 用户,用户具有所给密码,用户可以使用这些凭证登录到 Grafana URL。

验证:

使用凭证登录到 Grafana:

语法

https://HOST_NAME:PORT

https://HOST_NAME:PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

https://host01:3000/

https://host01:3000/Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.10. 手动启用 Red Hat Ceph Storage Dashboard

如果您在引导过程中使用 --skip-dashboard 选项安装了 Red Hat Ceph Storage 集群,仪表板 URL 和凭证不会出现在引导输出中。您可以使用命令行界面手动启用仪表板。虽然部署了 Prometheus、Grafana、Alertmanager、Alertmanager 和 node-exporter 等监控堆栈组件,但它们会被禁用,您必须手动启用。

先决条件

-

在 bootstrap 中使用

--skip-dashboard选项安装运行的 Red Hat Ceph Storage 集群。 - 需要启用控制面板的主机的根级别访问权限。

流程

登录到 Cephadm shell:

示例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查 Ceph Manager 服务:

示例

[ceph: root@host01 /]# ceph mgr services { "prometheus": "http://10.8.0.101:9283/" }[ceph: root@host01 /]# ceph mgr services { "prometheus": "http://10.8.0.101:9283/" }Copy to Clipboard Copied! Toggle word wrap Toggle overflow 您可以看到没有配置 Dashboard URL。

启用 dashboard 模块:

示例

[ceph: root@host01 /]# ceph mgr module enable dashboard

[ceph: root@host01 /]# ceph mgr module enable dashboardCopy to Clipboard Copied! Toggle word wrap Toggle overflow 为仪表板访问创建自签名证书:

示例

[ceph: root@host01 /]# ceph dashboard create-self-signed-cert

[ceph: root@host01 /]# ceph dashboard create-self-signed-certCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意您可以禁用证书验证以避免认证错误。

检查 Ceph Manager 服务:

示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 admin 用户和密码以访问 Red Hat Ceph Storage 仪表板:

语法

echo -n "PASSWORD" > PASSWORD_FILE ceph dashboard ac-user-create admin -i PASSWORD_FILE administrator

echo -n "PASSWORD" > PASSWORD_FILE ceph dashboard ac-user-create admin -i PASSWORD_FILE administratorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# echo -n "p@ssw0rd" > password.txt [ceph: root@host01 /]# ceph dashboard ac-user-create admin -i password.txt administrator

[ceph: root@host01 /]# echo -n "p@ssw0rd" > password.txt [ceph: root@host01 /]# ceph dashboard ac-user-create admin -i password.txt administratorCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 启用监控堆栈。详情请参阅 Red Hat Ceph Storage Dashboard 指南中的 启用监控堆栈 部分。

2.11. 在仪表板中使用单点登录

Ceph 控制面板支持外部身份验证用户,可选择 Security Assertion Markup Language (SAML) 2.0 协议,或使用 OAuth2 代理(oauth2-proxy)。在将单点登录(SSO)与 Ceph 控制面板搭配使用之前,请创建控制面板用户帐户并分配任何必要的角色。Ceph 控制面板完成用户授权,然后现有的身份提供程序(IdP)完成身份验证过程。您可以使用 SAML 协议或 oauth2-proxy 启用单点登录。

Red Hat Ceph Storage 支持使用 RHSSO (Keycloak)仪表板 SSO 和多因素身份验证。

OAuth2 SSO 使用 oauth2-proxy 服务与 Ceph 管理网关(mgmt-gateway)一起使用,从而提供统一访问和改进的用户体验。

OAuth2 SSO、mgmt-gateway 和 oauth2-proxy 服务是技术预览。

有关 Ceph 管理网关和 OAuth2 代理服务的更多信息,请参阅使用 Ceph 管理网关(mgmt-gateway)和使用 OAuth2 代理(oauth2-proxy)服务。

有关红帽构建的 Keycloack 的更多信息,请参阅红帽客户门户网站上的 红帽 构建 Keycloak。

2.11.1. 创建管理员帐户,将用户同步到 Ceph 仪表板

您必须创建 admin 帐户,以便将用户同步到 Ceph 仪表板。

在创建了帐户后,请使用 Red Hat Single Sign-on(SSO)将用户同步到 Ceph 仪表板。请参阅 Red Hat Ceph Storage 仪表板指南中的使用 Red Hat Single Sign-On 将用户同步到 Ceph 仪表板。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 控制面板的管理员级别访问权限。

- 用户添加到仪表板中。

- 所有主机上的 root 级别访问权限。

- 安装了 Java OpenJDK。如需更多信息,请参阅红帽客户门户网站中的 Installing and using OpenJDK 8 for RHEL 指南中的 Installing a JRE on RHEL by using yum 部分。

- 从 ZIP 文件安装的 Red Hat Single Sign-On。请参阅红帽客户门户网站上的 Red Hat Single Sign -On 的 Server 安装和配置指南中的 从 ZIP 文件安装 RH-SSO 部分。

流程

- 在安装了 Red Hat Ceph Storage 的系统中下载 Red Hat Single Sign-On 7.4.0 服务器。

解压文件夹:

unzip rhsso-7.4.0.zip

[root@host01 ~]# unzip rhsso-7.4.0.zipCopy to Clipboard Copied! Toggle word wrap Toggle overflow 进入

standalone/configuration目录并打开standalone.xml进行编辑:cd standalone/configuration vi standalone.xml

[root@host01 ~]# cd standalone/configuration [root@host01 configuration]# vi standalone.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在新创建的

rhsso-7.4.0文件夹的bin目录中,运行add-user-keycloak脚本来添加初始管理员用户:./add-user-keycloak.sh -u admin

[root@host01 bin]# ./add-user-keycloak.sh -u adminCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

将

localhost和两个127.0.0.1实例的所有实例替换为安装 Red Hat SSO 的计算机的 IP 地址。 启动服务器。在

rh-sso-7.4文件夹的bin目录中,运行独立引导脚本:./standalone.sh

[root@host01 bin]# ./standalone.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 admin 账户,https: IP_ADDRESS :8080/auth,带有一个用户名和密码:

注意只有在第一次登录到控制台时,才需要创建一个 admin 帐户。

- 使用创建的凭据登录 admin 控制台。

2.11.2. 使用 Red Hat Single Sign-On 将用户同步到 Ceph 仪表板

您可以使用红帽单点登录(SSO)与轻量级目录访问协议(LDAP)集成来把用户同步到 Red Hat Ceph Storage 仪表板。

用户被添加到特定域中,它们可以通过 SSO 访问仪表板,而无需密码进行任何额外的要求。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 控制面板的管理员级别访问权限。

- 用户添加到仪表板中。请参阅 Red Hat Ceph Storage Dashboard Guide 中的 Creating users on Ceph dashboard 部分。

- 所有主机上的 root 级别访问权限。

- 为同步用户创建的 admin 帐户。请参阅 Red Hat Ceph Storage Dashboard Guide中的创建管理员帐户,以便将用户同步到 Ceph 仪表板部分。

流程

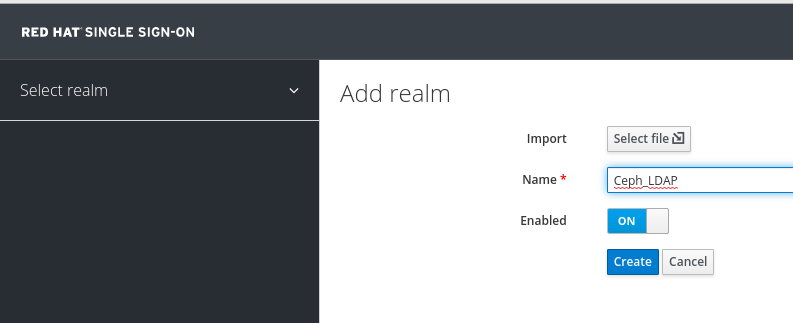

- 要创建域,点 Master 下拉菜单。在这个域中,您可以提供对用户和应用程序的访问权限。

在 Add Realm 窗口中,输入区分大小写的域名,并将参数 Enabled 设置为 ON,点 Create :

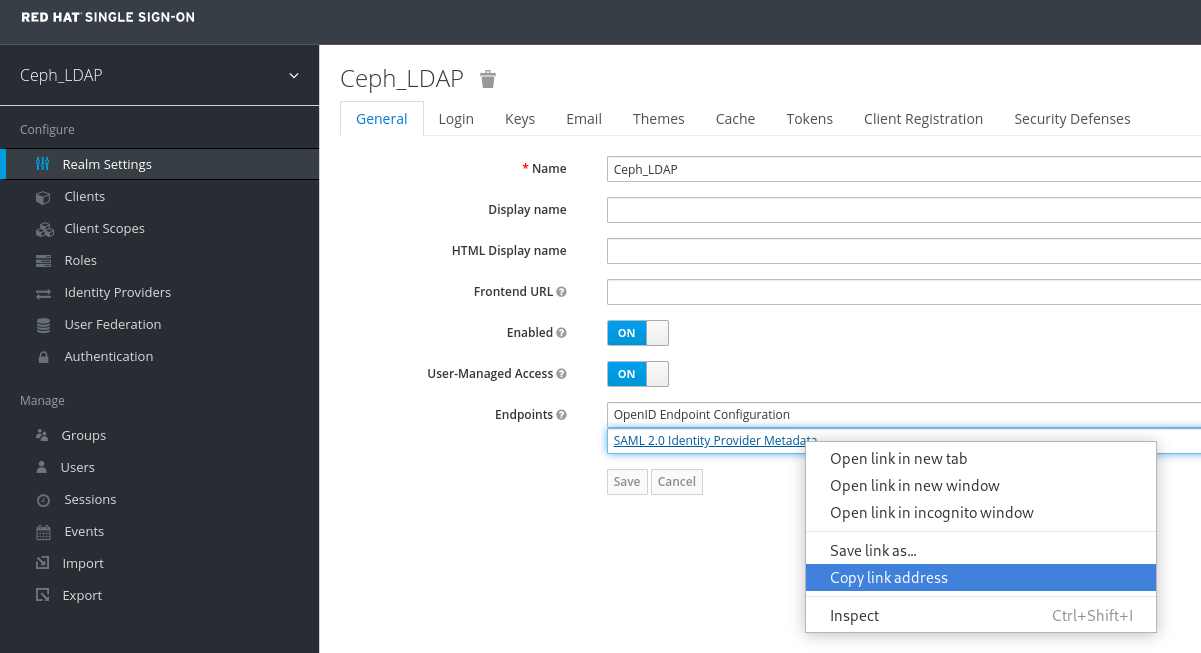

在 Realm Settings 选项卡中,设置以下参数并点 Save :

- enabled - ON

- 用户管理的访问 - ON

记录下 SAML 2.0 身份提供商元数据的链接地址,粘贴到 Client Settings 中。

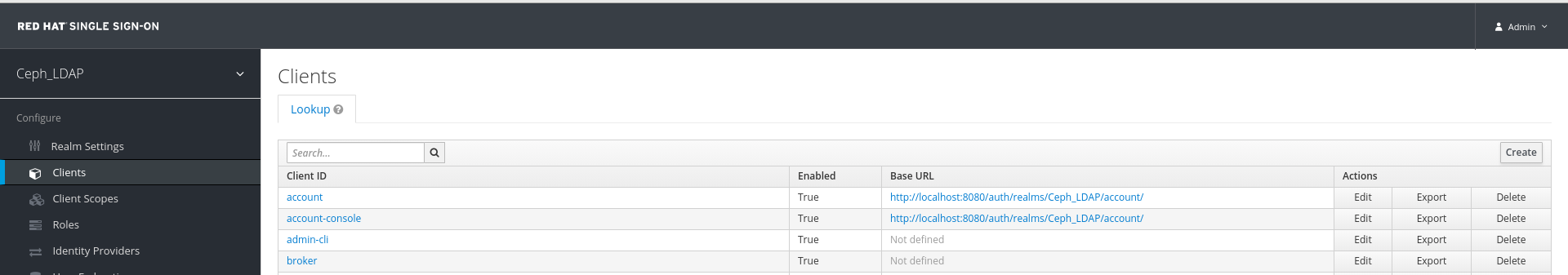

在 Clients 选项卡中,点 Create :

在 Add Client 窗口中设置以下参数,点 Save :

Client ID - BASE_URL:8443/auth/saml2/metadata

示例

https://example.ceph.redhat.com:8443/auth/saml2/metadata

- 客户端协议 - saml

在 Client 窗口中,在 Settings 选项卡中设置以下参数:

Expand 表 2.2. 客户端设置标签页 参数的名称 语法 示例 客户端 IDBASE_URL:8443/auth/saml2/metadata

https://example.ceph.redhat.com:8443/auth/saml2/metadata

EnabledON

ON

客户端协议saml

saml

包括 AuthnStatementON

ON

签署文档ON

ON

签名算法RSA_SHA1

RSA_SHA1

SAML 签名密钥名称KEY_ID

KEY_ID

有效重定向 URLBASE_URL:8443/*

https://example.ceph.redhat.com:8443/*

基本 URLBASE_URL:8443

https://example.ceph.redhat.com:8443/

Master SAML 处理 URLhttps://localhost:8080/auth/realms/REALM_NAME/protocol/saml/descriptor

https://localhost:8080/auth/realms/Ceph_LDAP/protocol/saml/descriptor

注意从 Realm Settings 选项卡中粘贴 SAML 2.0 身份提供程序元数据的链接。

在 Fine Grain SAML Endpoint Configuration 下,设置以下参数并点 Save :

Expand 表 2.3. 精细的 SAML 配置 参数的名称 语法 Example Assertion Consumer Service POST Binding URL

BASE_URL:8443/#/dashboard

https://example.ceph.redhat.com:8443/#/dashboard

Assertion Consumer Service Redirect Binding URL

BASE_URL:8443/#/dashboard

https://example.ceph.redhat.com:8443/#/dashboard

Logout Service Redirect Binding URL

BASE_URL:8443/

https://example.ceph.redhat.com:8443/

在 Clients 窗口的 Mappers 选项卡中,设置以下参数并点 Save :

Expand 表 2.4. 客户端映射程序标签 参数的名称 Value 协议saml

名称username

Mapper Property用户属性

属性username

SAML 属性名称username

在 Clients Scope 选项卡中,选择 role_list :

- 在 Mappers 选项卡中,选择 角色列表,将 Single Role Attribute 设置为 ON。

选择 User_Federation 选项卡:

- 在 User Federation 窗口中,从下拉菜单中选择 ldap :

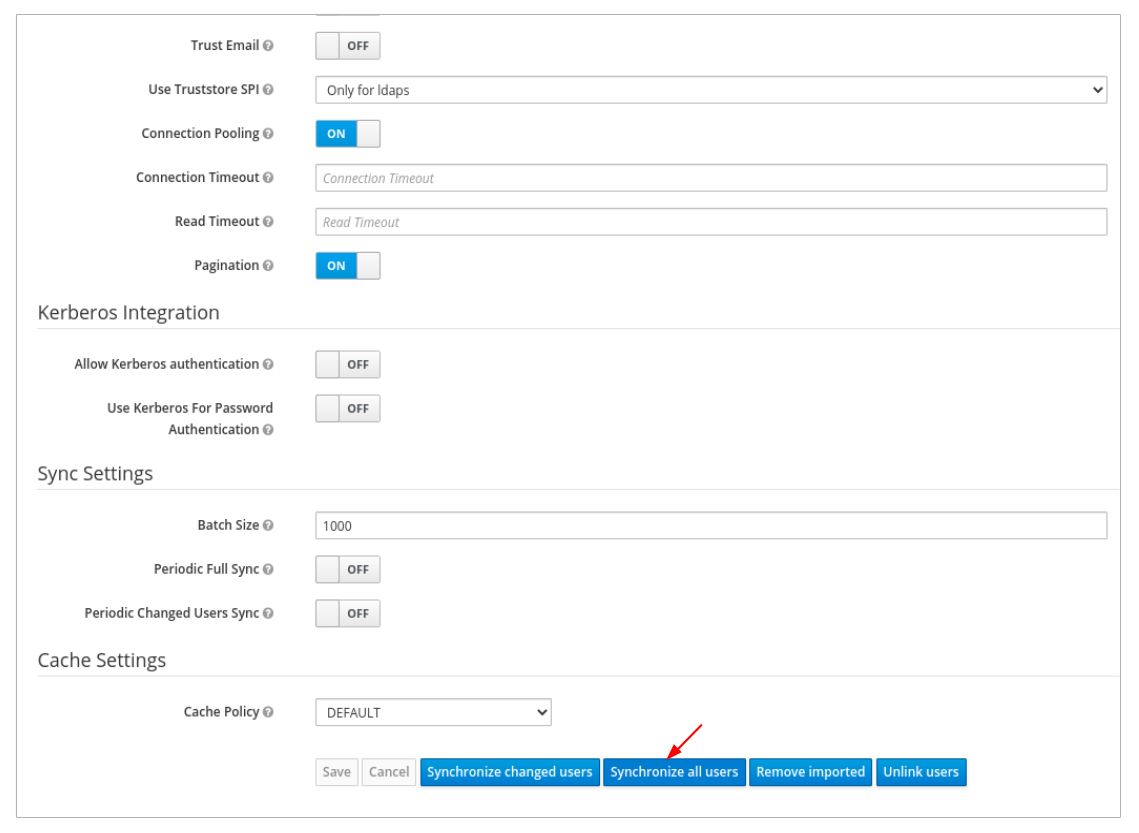

在 User_Federation 窗口中,Settings 选项卡设置以下参数,然后单击保存 :

Expand 表 2.5. 用户 Federation Settings 标签页 参数的名称 Value 控制台显示名称rh-ldap

导入用户ON

Edit_ModeREAD_ONLY

用户名 LDAP 属性username

RDN LDAP 属性username

UUID LDAP 属性nsuniqueid

用户对象类inetOrgPerson, organizationalPerson, rhatPerson

连接 URL示例:ldap://ldap.corp.redhat.com,点 Test Connection。您将收到 LDAP 连接成功的通知。

用户 DNou=users, dc=example, dc=com

绑定类型simple

点 Test authentication。您将收到 LDAP 身份验证成功的通知。

在 Mappers 选项卡中,选择 first name 行并编辑以下参数,然后单击 Save :

- LDAP 属性 - 指定名称

在 User_Federation 选项卡,Settings 选项卡中,点 Synchronize all users:

您将收到用户同步成功完成的通知。

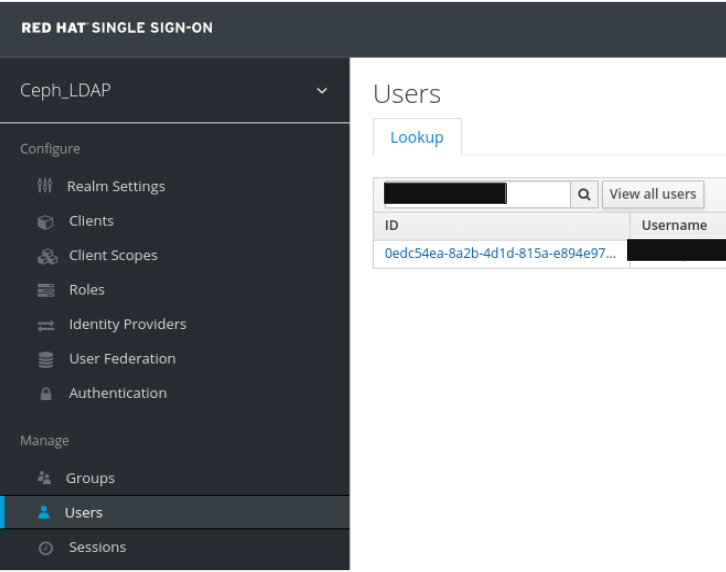

在 Users 选项卡中,搜索添加到仪表板中的用户并点击 Search 图标:

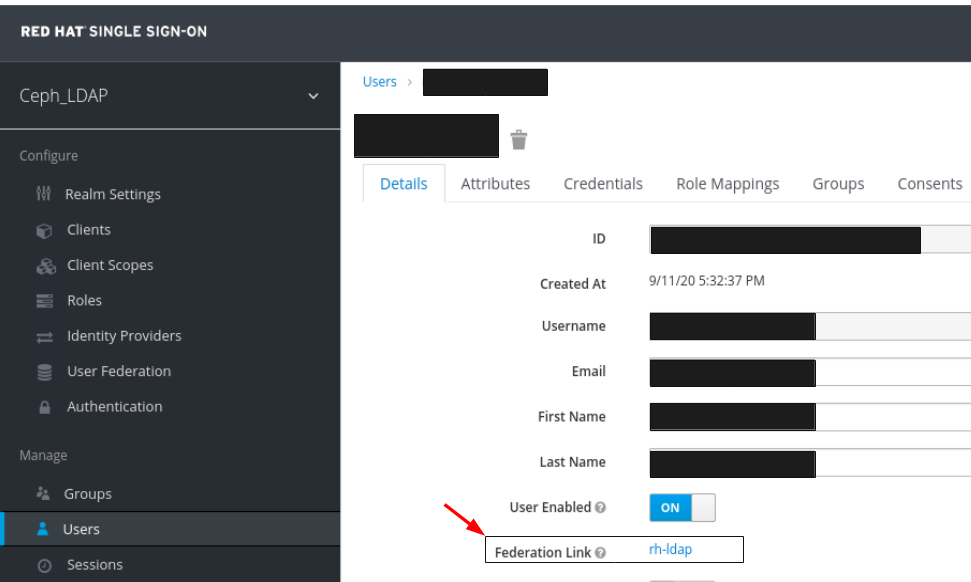

要查看用户,请点特定行。您应该看到联邦链接,作为提供给用户联邦的名称。

重要不要手动添加用户,因为用户不会由 LDAP 同步。如果手动添加,点 Delete 来删除用户。

注意如果 Red Hat SSO 当前正在您的工作环境中使用,请务必先启用 SSO。有关更多信息,请参阅 Red Hat Ceph Storage Dashboard Guide 中的 Enabling Single Sign-On with SAMLE 2.0 for the Ceph Dashboard 部分。

验证

用户添加到 realm,控制面板可以使用其电子邮件地址和密码访问 Ceph 仪表板。

示例

https://example.ceph.redhat.com:8443

2.11.3. 为 Ceph 仪表板启用带有 SAML 2.0 的单点登录

Ceph 控制面板支持使用安全断言标记语言(SAML)2.0 协议进行外部身份验证。在将单点登录(SSO)与 Ceph 控制面板搭配使用之前,请创建控制面板用户帐户并分配所需的角色。Ceph 控制面板对用户执行授权,身份验证过程由现有的身份提供程序(IdP)执行。您可以使用 SAML 协议启用单点登录。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 安装 Ceph 控制面板.

- 对 Ceph Manager 主机的 root 级别访问权限。

流程

要在 Ceph Dashboard 中配置 SSO,请运行以下命令:

语法

cephadm shell CEPH_MGR_HOST ceph dashboard sso setup saml2 CEPH_DASHBOARD_BASE_URL IDP_METADATA IDP_USERNAME_ATTRIBUTE IDP_ENTITY_ID SP_X_509_CERT SP_PRIVATE_KEY

cephadm shell CEPH_MGR_HOST ceph dashboard sso setup saml2 CEPH_DASHBOARD_BASE_URL IDP_METADATA IDP_USERNAME_ATTRIBUTE IDP_ENTITY_ID SP_X_509_CERT SP_PRIVATE_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

cephadm shell host01 ceph dashboard sso setup saml2 https://dashboard_hostname.ceph.redhat.com:8443 idp-metadata.xml username https://10.70.59.125:8080/auth/realms/realm_name /home/certificate.txt /home/private-key.txt

[root@host01 ~]# cephadm shell host01 ceph dashboard sso setup saml2 https://dashboard_hostname.ceph.redhat.com:8443 idp-metadata.xml username https://10.70.59.125:8080/auth/realms/realm_name /home/certificate.txt /home/private-key.txtCopy to Clipboard Copied! Toggle word wrap Toggle overflow 替换

-

CEPH_MGR_HOST 与 Ceph

mgr主机。例如,host01 - CEPH_DASHBOARD_BASE_URL 带有可以访问 Ceph 仪表板的基本 URL。

- IDP_METADATA,包含到远程或本地路径的 URL,或 IdP 元数据 XML 的内容。支持的 URL 类型包括 http、https 和 文件。

- 可选:IDP_USERNAME_ATTRIBUTE,包含用于从身份验证响应中获取用户名的属性。默认为 uid。

- 可选 :当 IdP 元数据中存在多个实体 ID 时,使用 IdP 实体 ID 的 IDP_ENTITY_ID。

- 可选:SP_X_509_CERT,包含 Ceph Dashboard 用来签名和加密的证书文件路径。

- 可选 :SP_PRIVATE_KEY 以及 Ceph Dashboard 用来签名和加密的私钥的文件路径。

-

CEPH_MGR_HOST 与 Ceph

验证当前的 SAML 2.0 配置:

语法

cephadm shell CEPH_MGR_HOST ceph dashboard sso show saml2

cephadm shell CEPH_MGR_HOST ceph dashboard sso show saml2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

cephadm shell host01 ceph dashboard sso show saml2

[root@host01 ~]# cephadm shell host01 ceph dashboard sso show saml2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要启用 SSO,运行以下命令:

语法

cephadm shell CEPH_MGR_HOST ceph dashboard sso enable saml2 SSO is "enabled" with "SAML2" protocol.

cephadm shell CEPH_MGR_HOST ceph dashboard sso enable saml2 SSO is "enabled" with "SAML2" protocol.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

cephadm shell host01 ceph dashboard sso enable saml2

[root@host01 ~]# cephadm shell host01 ceph dashboard sso enable saml2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 打开您的仪表板 URL。

示例

https://dashboard_hostname.ceph.redhat.com:8443

https://dashboard_hostname.ceph.redhat.com:8443Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 在 SSO 页面上,输入登录凭据。SSO 会重定向到仪表板 Web 界面。

2.11.4. 使用 OAuth2 协议将 Red Hat SSO 配置为身份提供程序

您可以通过将 Red Hat SSO 配置为身份提供程序(IdP),为 IBM Storage Ceph 控制面板启用单点登录(SSO)。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 具有对应子卷的子卷组。

-

启用 Ceph 管理网关(

mgmt-gateway)服务。有关更多信息,请参阅启用 Ceph 管理网关。 -

启用 OAuth2 代理服务(

oauth2-proxy)。如需更多信息,请参阅启用 OAuth2 代理服务。 - 在配置身份提供程序前,请确保配置了 oauth2 代理和身份提供程序。

流程

在 Red Hat SSO 中创建域。

- 单击 Master HEKETIdrop-down 菜单,再选择 Add Realm。

- 为域输入一个区分大小写的名称。

- 设置 Enabled HEKETIto ON ,点 Create。

配置 realm 设置。

- 进入 Realm Settings swigtab。

- 将 Enabled 设置为 ON,将 用户管理的访问权限 设置为 ON。

- 点* swigSave*。

- 复制 swigOpenID Endpoint Configuration swigURL。对于 OAuth2 Proxy 设置,请使用此配置中的 swigissuer swigendpoint。

示例

Issuer: http://<your-ip>:<port>/realms/<realm-name>

Issuer: http://<your-ip>:<port>/realms/<realm-name>创建和配置 OIDC 客户端。

- 创建类型为 swigOpenID Connect 的客户端。

- 启用客户端身份验证和授权。

设置重定向 URL。

- 有效的重定向 URL: https://<host_name|IP_address>/oauth2/callback

- 有效的注销重定向 URL: https://<host_name|IP_address>/oauth2/sign_out

- 进入 Credentials 选项卡,并记下 wagonclient_id swigand swigclient_secret 的值。这些凭证需要配置 swigoauth2-proxywagonservice。

创建用于仪表板访问的角色。

- 导航到 Roles 选项卡。

- 创建角色并将其分配给 OIDC 客户端。

- 使用 IBM Storage Ceph 仪表板支持的角色名称。

创建用户并分配角色。

- 创建新用户。

- 定义用户凭据。

- 打开 swigRole Mappings swigtab,并将之前创建的角色分配给该用户。

为仪表板启用 SSO。

语法

ceph dashboard sso enable

ceph dashboard sso enableCopy to Clipboard Copied! Toggle word wrap Toggle overflow

现在,为 Ceph 管理堆栈启用了 SSO。当用户访问控制面板时,它们会被重定向到 Red Hat SSO 登录页面。身份验证成功后,会根据 Red Hat SSO 中指定的角色在所有监控堆栈(包括仪表板、Grafana 和 Prometheus)授予用户访问权限。

2.11.5. 使用 OAuth2 协议将 IBM Security Verify 配置为身份提供程序

您可以通过将 IBM Security Verify 配置为身份提供程序(IdP)为 IBM Storage Ceph 仪表板启用单点登录(SSO)。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 安装 Ceph 控制面板.

-

启用 Ceph 管理网关(

mgmt-gateway)服务。有关更多信息,请参阅启用 Ceph 管理网关。 -

启用 OAuth2 代理服务(

oauth2-proxy)。如需更多信息,请参阅启用 OAuth2 代理服务。

流程

- 从 IBM Security Verify 应用程序,进入到 Applications > Application,然后点 Add An Application。

- 在 Application Type 下,选择 Custom Application,再单击 Add Application。

- 在 General 选项卡下添加公司名称。

- 导航到 Sign-on 选项卡,然后从 Sign-on Method 下拉列表中选择 Open ID Connect 1.0。

在 Application URL 部分下,输入 mgmt-gateway URL。

示例

https://<HOSTNAME/IP_OF_THE_MGMT-GATEWAY_HOST>

https://<HOSTNAME/IP_OF_THE_MGMT-GATEWAY_HOST>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 清除 PKCE 验证 复选框。

从 Redirect URIs 部分,填写重定向 URI。使用以下重定向 URL 格式:

从 Token settings 中,选择 JWT 作为访问令牌格式。对于以下每个属性,在对应字段中输入详情,然后从下拉列表中选择对应的属性源:

- 名称 | preferred_username

- 电子邮件 | 电子邮件

- 从 Consent Settings,从下拉列表中选择 Do not ask for consent。

- 在 Custom Scopes 中清除 Restrict Custom Scopes 复选框,然后点 Save。

添加用户。

- 进入 Directory > Users & Groups 并点 Add User。

- 提供所需的用户名和有效电子邮件地址。初始用户凭证发送到提供的电子邮件地址。

- 点击 Save。

进入 Directory > Attributes,再点 Add Attribute。

- 选中 Custom Attribute,然后选择 Single Sign On (SSO) 复选框。点 Next。

- 在 Attribute Name 字段中,输入 roles。

- 在 Data Type 下,从下拉列表中选择 Multivalue String。

- 点 Additional settings,从 Apply Transformation 下拉列表中选择 Lowercase,然后点 Next。

- 单击 Add Attribute。

进入 Directory > Users & Groups 并编辑新添加的用户。

- 选择 View Extended Profile。

- 从 自定义用户属性,添加所需的仪表板角色。例如,管理员、read-only、block-manager 等。此用户会自动继承仪表板角色。

- 单击 Save settings。

进入 Applications > Application,点在第 2 步中创建的自定义应用程序的 Settings 图标。

- 在 Sign-on 选项卡中,进入 *Token setting*s。

- 对于 roles 属性,在对应的字段中输入详情,然后从下拉列表中选择对应的属性源: roles | roles

- 在 Entitlements 选项卡中,添加新创建的用户并点 Save。

2.11.6. 启用 OAuth2 单点登录

为 Ceph 控制面板启用 OAuth2 单点登录(SSO)。OAuth2 SSO 使用 oauth2-proxy 服务。

为 Red Hat Ceph Storage 8.0 启用 OAuth2 单点登录是技术预览。

红帽产品服务级别协议(SLA)不支持技术预览功能,且其功能可能并不完善,因此红帽不建议在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。如需了解更多详细信息,请参阅红帽技术预览功能的支持范围。

先决条件

在开始前,请确保您有以下先决条件:

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 安装 Ceph 控制面板.

- Ceph 管理器主机的 root 级别访问权限。

- 在 7.6.0 上带有 Red Hat Single-Sign 的 admin 帐户。如需更多信息,请参阅 使用红帽单点登录 7.6.0 创建管理员帐户。

-

启用 Ceph 管理网关(

mgmt-gateway)服务。有关更多信息,请参阅启用 Ceph 管理网关。 -

启用 OAuth2 代理服务(

oauth2-proxy)。如需更多信息,请参阅启用 OAuth2 代理服务。 - 您应该拥有运行 Red Hat Single-Sign-On 7.6.0 的 admin 帐户,运行 OAuth2 协议,或 IBM Security Verify with OAuth2 协议正在运行。如需更多信息,请参阅使用 OAuth2 协议将 IBM 安全验证配置为身份提供程序。

流程

启用 Ceph 控制面板 OAuth2 SSO 访问。

语法

ceph dashboard sso enable oauth2

ceph dashboard sso enable oauth2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph dashboard sso enable oauth2 SSO is "enabled" with "oauth2" protocol.

[ceph: root@host01 /]# ceph dashboard sso enable oauth2 SSO is "enabled" with "oauth2" protocol.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 设置有效的重定向 URL。

语法

https://HOST_NAME|IP_ADDRESS/oauth2/callback

https://HOST_NAME|IP_ADDRESS/oauth2/callbackCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意此 URL 必须与 OAuth2 代理服务中配置的重定向 URL 相同。

配置有效的用户角色。

注意对于管理员角色,请使用管理员或只读访问权限配置 IDP 用户。

打开您的仪表板 URL。

示例

https://<hostname/ip address of mgmt-gateway host>

https://<hostname/ip address of mgmt-gateway host>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 在 SSO 页面上,输入身份提供程序(IdP)凭据。SSO 重定向到仪表板 Web 界面。

验证

使用 cephadm shell ceph dashboard sso status 命令随时检查 SSO 状态。

示例

cephadm shell ceph dashboard sso status

[root@host01 ~]# cephadm shell ceph dashboard sso status

SSO is "enabled" with "oauth2" protocol.2.11.7. 为 Ceph 仪表板禁用单点登录

您可以随时为 Ceph 控制面板禁用 SAML 2.0 和 OAuth2 SSO。

先决条件

在开始前,请确保您有以下先决条件:

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 安装 Ceph 控制面板.

- 对 Ceph Manager 主机的 root 级别访问权限。

- 为 Ceph Dashboard 启用单点登录

流程

要查看 SSO 的状态,请运行以下命令:

语法

cephadm shell CEPH_MGR_HOST ceph dashboard sso status

cephadm shell CEPH_MGR_HOST ceph dashboard sso statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

cephadm shell host01 ceph dashboard sso status

[root@host01 ~]# cephadm shell host01 ceph dashboard sso status SSO is "enabled" with "SAML2" protocol.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要禁用 SSO,请运行以下命令:

语法

cephadm shell CEPH_MGR_HOST ceph dashboard sso disable SSO is "disabled".

cephadm shell CEPH_MGR_HOST ceph dashboard sso disable SSO is "disabled".Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

cephadm shell host01 ceph dashboard sso disable

[root@host01 ~]# cephadm shell host01 ceph dashboard sso disableCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 3 章 管理 Ceph 仪表板上的角色

作为存储管理员,您可以在仪表板上创建、编辑、克隆和删除角色。

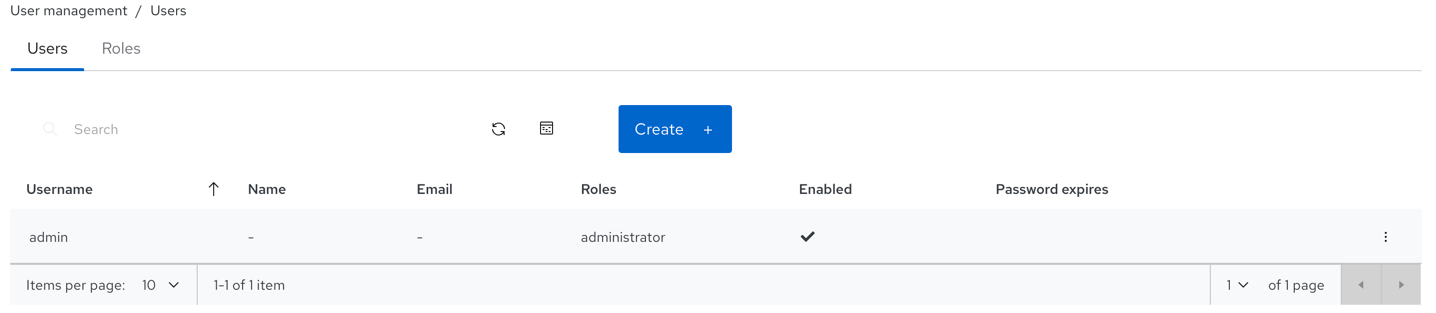

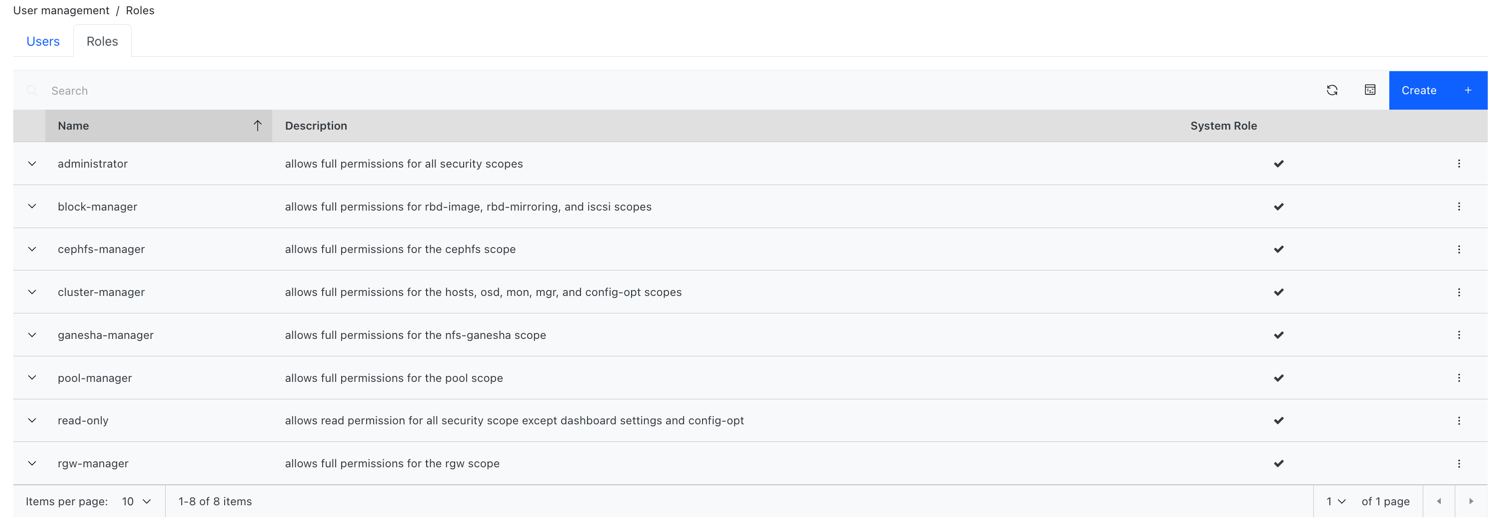

默认情况下,有 8 个系统角色。您可以创建自定义角色,并授予这些角色的权限。这些角色可以根据要求分配给用户。

本节涵盖了以下管理任务:

3.1. Ceph 仪表板上的用户角色和权限

用户帐户与一组角色关联,它们定义可以访问的特定仪表板功能。前往 Dashboard settings→User management 来查看用户角色和权限。

Red Hat Ceph Storage 仪表板功能或模块在安全范围内分组。安全范围是预定义的和静态。Red Hat Ceph Storage 仪表板中当前可用的安全范围是:

- CephFS :包括与 CephFS 管理相关的所有功能。

- config-opt :包含与 Ceph 配置选项管理相关的所有功能。

- dashboard-settings :允许编辑仪表板设置。

- Grafana :包括与 Grafana 代理相关的所有功能。

- Host :包括与 Hosts 菜单条目相关的所有功能。

- log :包含与 Ceph 日志管理相关的所有功能。

- manager: 包含与 Ceph 管理器管理相关的所有功能。

- monitor :包含与 Ceph 监视器管理相关的所有功能。

- NFS-ganesha :包含与 NFS-Ganesha 管理相关的所有功能。

- OSD :包含与 OSD 管理相关的所有功能。

- 池 :包含与池管理相关的所有功能。

- Prometheus :包括与 Prometheus 警报管理相关的所有功能。

- rbd-image: 包含与 RBD 镜像管理相关的所有功能。

- rbd-mirroring :包含与 RBD 镜像管理相关的所有功能。

- rgw :包含与 Ceph 对象网关(RGW)管理相关的所有功能。

角色指定了一个安全范围和一组权限之间的一组映射。有四种权限 :

- 读

- 创建

- Update(更新)

- 删除

system roles 列表包括

- administrator :允许所有安全范围的完整权限。

- block-manager :允许 RBD-image 和 RBD-mirroring 范围的完整权限。

- cephfs-manager :允许 Ceph 文件系统范围的完整权限。

- cluster-manager :允许主机、OSD、监控、管理器和 config-opt 范围的完整权限。

- ganesha-manager :允许 NFS-Ganesha 范围的完整权限。

- pool-manager :允许池范围的完整权限。

- read-only :允许所有安全范围的读取权限,但仪表板设置和 config-opt 范围除外。

- rgw-manager :允许 Ceph 对象网关范围的完整权限。

例如,您需要提供 rgw-manager 对所有 Ceph 对象网关操作的用户的访问权限。

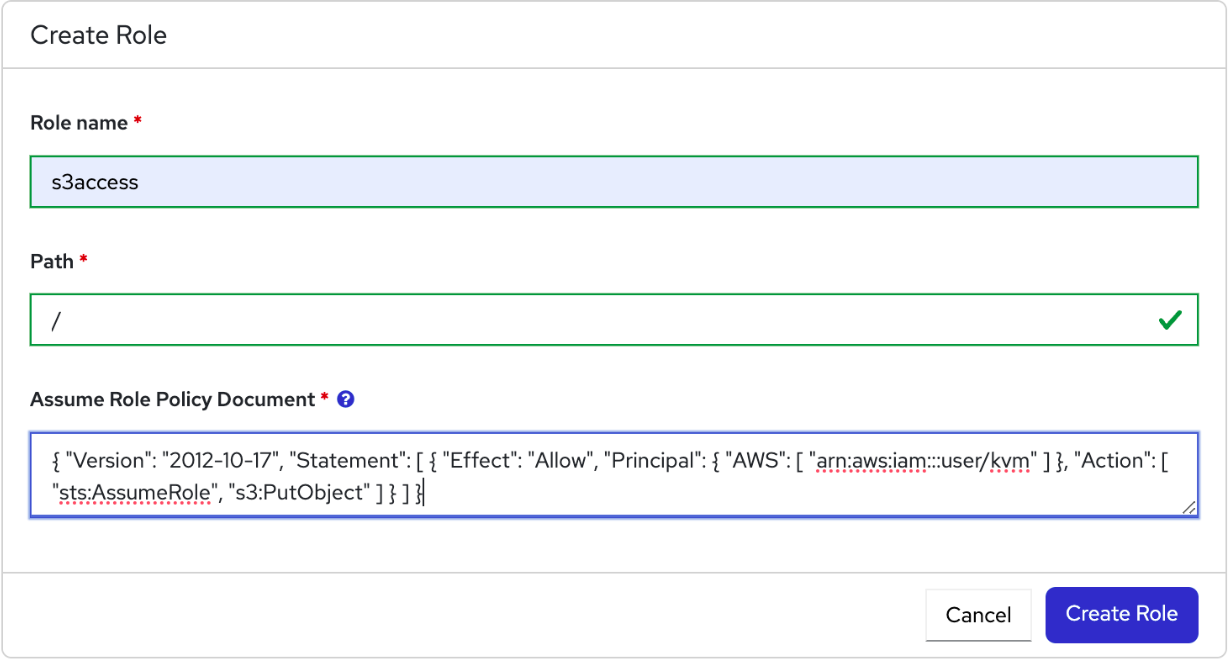

3.2. 在 Ceph 仪表板上创建角色

您可以在仪表板上创建自定义角色,并且这些角色可以根据其角色分配给用户。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 控制面板的管理员级别访问权限。

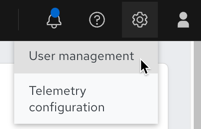

流程

- 登录到仪表板。

点 Dashboard Settings 图标,然后点 User Management。

- 在 Roles 选项卡上,单击 Create。

在 Create Role 窗口中,设置 Name,Description,并为此角色选择 Permissions,然后单击 Create Role 按钮。

在本例中,使用

ganesha-manager和rgw-manager角色分配的用户可以管理所有 NFS-Ganesha 网关和 Ceph 对象网关操作。- 您会收到一条通知角色已成功创建。

- 点行的 Expand/Collapse 图标,以查看提供给角色的详细信息和权限。

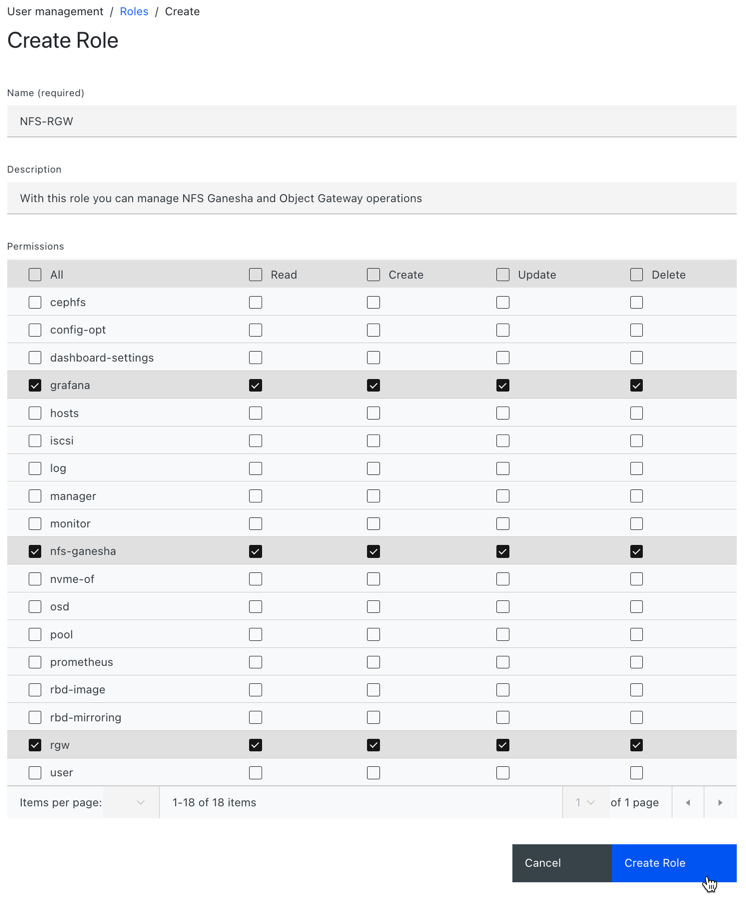

3.3. 编辑 Ceph 仪表板的角色

控制面板允许您在仪表板上编辑角色。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 控制面板的管理员级别访问权限。

- 在仪表板上创建角色。

流程

- 登录到仪表板。

点 Dashboard Settings 图标,然后点 User Management。

- 在 Roles 选项卡上,点击您要编辑的角色。

在 Edit Role 窗口中,编辑参数,然后点 Edit Role。

- 您会收到成功更新该角色的通知。

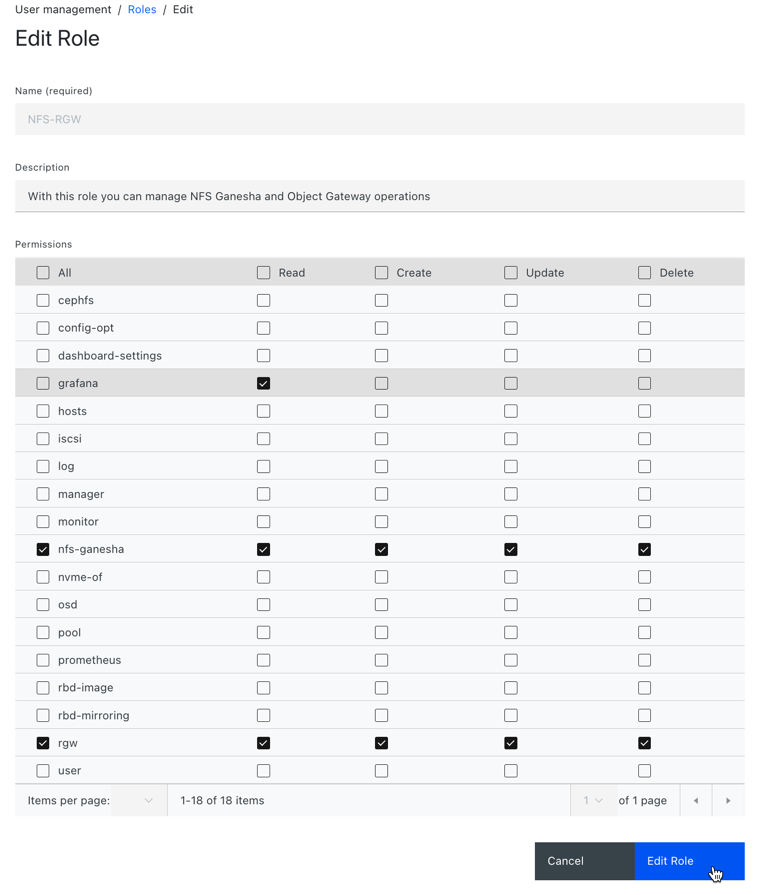

3.4. 在 Ceph 仪表板上克隆角色

当您想要为现有角色分配额外权限时,您可以克隆系统角色并在 Red Hat Ceph Storage 控制面板中进行编辑。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 控制面板的管理员级别访问权限。

- 角色在仪表板上创建。

流程

- 登录到仪表板。

点 Dashboard Settings 图标,然后点 User Management。

- 在 Roles 选项卡上,点击您要克隆的角色。

- 从 Edit 下拉菜单中选择 Clone。

在 Clone Role 对话框中,输入角色的详细信息,然后单击 Clone Role。

- 克隆角色后,您可以根据要求自定义权限。

3.5. 删除 Ceph 仪表板的角色

您可以删除您在 Red Hat Ceph Storage 仪表板中创建的自定义角色。

您无法删除 Ceph 控制面板的系统角色。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 控制面板的管理员级别访问权限。

- 在仪表板上创建自定义角色。

流程

- 登录到仪表板。

单击 Dashboard Settings 图标,然后选择 User management。

- 在 Roles 选项卡上,点击您要删除的角色,然后从操作下拉菜单中选择 Delete。

- 在 Delete Role 通知中,选择 Yes, I am sure,再单击 Delete Role。

第 4 章 在 Ceph 仪表板上管理用户

作为存储管理员,您可以在 Red Hat Ceph Storage 仪表板上使用特定角色创建、编辑和删除用户。基于角色的访问权限控制会根据其角色和要求向每个用户提供。

您还可以在仪表板上创建、编辑、导入、导出和删除 Ceph 客户端身份验证密钥。创建身份验证密钥后,您可以使用命令行界面(CLI)轮转密钥。密钥轮转满足当前的行业和安全合规性要求。

本节涵盖了以下管理任务:

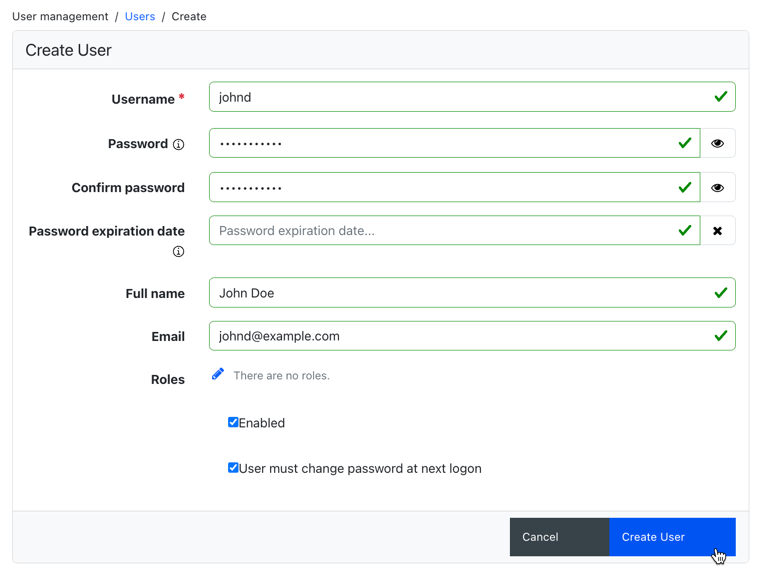

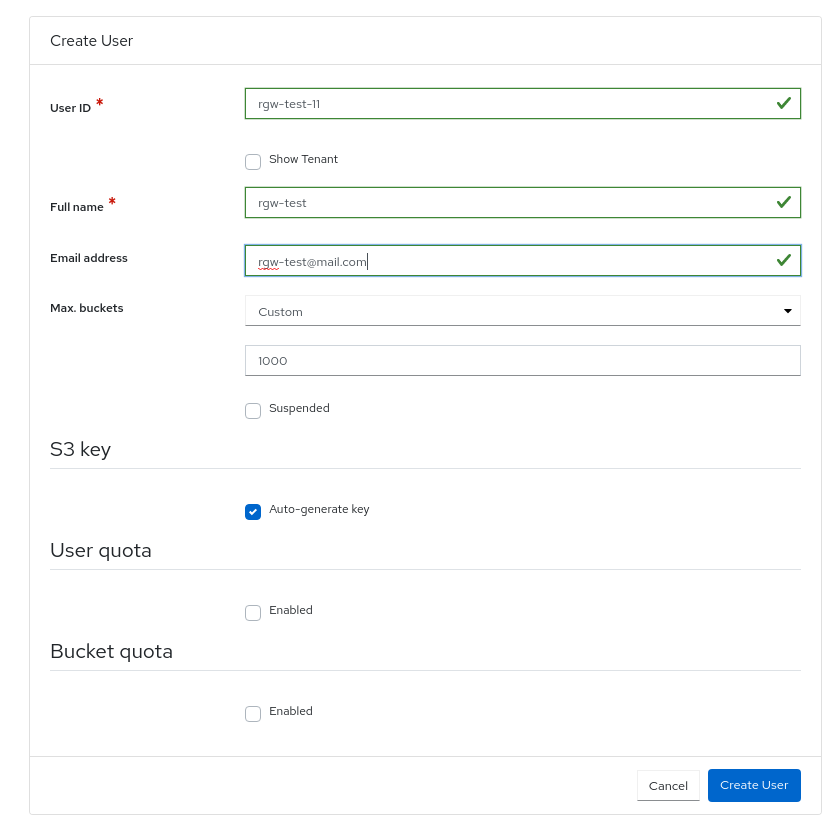

4.1. 在 Ceph 仪表板中创建用户

您可以根据其角色在 Red Hat Ceph Storage 仪表板中创建用户,并有足够的角色和权限。例如,如果您希望用户管理 Ceph 对象网关操作,您可以为该用户提供 rgw-manager 角色。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 控制面板的管理员级别访问权限。

Red Hat Ceph Storage 仪表板不支持更改用户密码时的任何电子邮件验证。此行为是有意设计的,因为控制面板支持单点登录(SSO),此功能可以委派给 SSO 提供程序。

流程

- 登录到仪表板。

点 Dashboard Settings 图标,然后点 User Management。

- 在 Users 选项卡中,点 Create。

在 Create User 窗口中,设置 Username 和其他参数,包括角色,然后点 Create User。

- 您收到用户创建成功的通知。

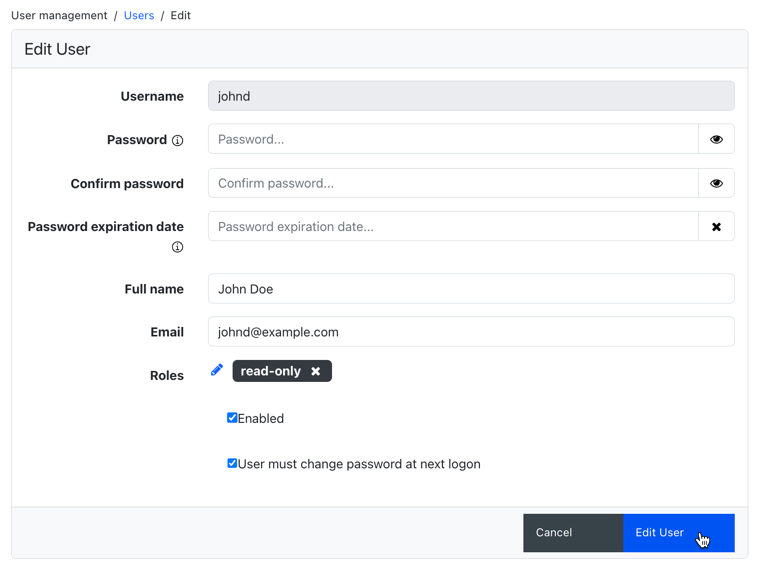

4.2. 在 Ceph 仪表板中编辑用户

您可以编辑 Red Hat Ceph Storage 仪表板中的用户。您可以根据要求修改用户的密码和角色。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 控制面板的管理员级别访问权限。

- 在控制面板上创建的用户。

流程

- 登录到仪表板。

点 Dashboard Settings 图标,然后点 User Management。

- 要编辑该用户,请点行。

- 在 Users 选项卡中,从 Edit 下拉菜单中选择 Edit。

在 Edit User 窗口中,编辑 password 和角色等参数,然后点 Edit User。

注意如果要禁用任何用户对 Ceph 仪表板的访问,可以在 Edit User 窗口中取消选择 Enabled 选项。

- 您收到用户创建成功的通知。

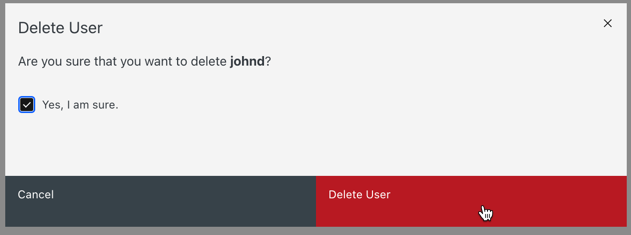

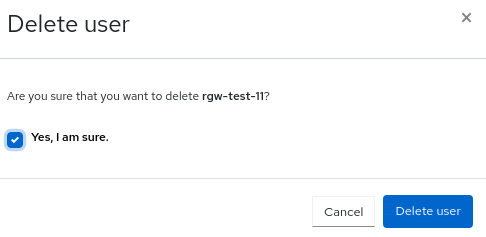

4.3. 删除 Ceph 仪表板中的用户

您可以删除 Ceph 仪表板中的用户。有些用户可能会从系统中删除。可以从 Ceph 控制面板删除对此类用户的访问权限。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 控制面板的管理员级别访问权限。

- 在控制面板上创建的用户。

流程

- 登录到仪表板。

点 Dashboard Settings 图标,然后点 User Management。

- 在 Users 选项卡中,点击您要删除的用户。

- 从 Edit 下拉菜单中选择 Delete。

在 Delete User notification 中,选择 Yes, I am sure 并点 Delete User。

4.4. 用户功能

Ceph 将数据 RADOS 对象存储在池内,与使用的 Ceph 客户端无关。Ceph 用户必须有权访问给定池才能读取和写入数据,并且必须具有可执行权限才能使用 Ceph 管理的命令。通过创建用户,您可以控制他们对 Red Hat Ceph Storage 集群、池和池中数据的访问。

Ceph 具有 用户类型 的概念,即始终是 客户端。您需要定义具有 TYPE.ID 的用户,其中 ID 是用户 ID,如 client.admin。此用户输入是因为 Cephx 协议不仅限于客户端,也供客户端使用,如 Ceph 监控器、OSD 和元数据服务器。区分用户类型有助于区分客户端用户和其他用户。这种区别简化了访问控制、用户监控和可追溯性。

4.4.1. 功能

Ceph 使用功能(大写)描述授予经过身份验证的用户的权限,以练习 monitor、OSD 和元数据服务器的功能。此能力根据应用程序标签来限制对池中的数据的访问、池中的命名空间或一组池。Ceph 管理用户在创建或更新用户时指定用户的功能。

您可以将功能设置为监控、管理器、OSD 和元数据服务器。

-

Ceph 监控功能包括

r、w和x访问设置。它们可以通过profile NAME从预定义的配置集应用。 -

OSD 功能包括

r、w、x、class-read和class-writeaccess 设置。它们可以通过profile NAME从预定义的配置集应用。 -

Ceph 管理器功能包括

r、w和x访问设置。它们可以通过profile NAME从预定义的配置集应用。 -

对于管理员,元数据服务器(MDS)功能包括

allow *。

Ceph 对象网关守护进程(radosgw)是 Red Hat Ceph Storage 集群的客户端,不表示为 Ceph 存储集群守护进程类型。

4.5. 访问功能

本节介绍可提供给 Ceph 用户或 Ceph 客户端的不同访问或实体功能,如块设备、对象存储、文件系统和原生 API。

另外,您可以在为客户端分配角色时描述功能配置文件。

allow, 描述-

守护进程的以前访问设置。仅表示 MDS 的

rw r, 描述- 授予用户 读取访问权限。需要 monitor 来检索 CRUSH map。

w, 描述- 授予用户对对象 的写入访问权限。

x, 描述-

授予用户调用类方法的能力,即 读取和写入,以及对 monitor 执行

auth操作。 class-read, 描述-

授予用户调用类读取方法的能力。

x的子集. class-write, 描述-

授予用户调用类写入方法的能力。

x的子集. - *,

所有, 描述 - 授予用户对特定守护进程或 池的读取、写入 和 执行权限,以及执行 admin 命令的能力。

以下条目描述了有效的功能配置集:

配置集 osd, 描述- 这仅适用于 Ceph Monitor。授予用户权限以 OSD 连接到其他 OSD 或 monitor。在 OSD 上延迟,使 OSD 能够处理复制心跳流量和状态报告。

配置集 mds, 描述- 这仅适用于 Ceph Monitor。授予用户权限以 MDS 连接到其他 MDS 或 monitor。

配置集 bootstrap-osd, 描述-

这仅适用于 Ceph Monitor。授予用户权限来引导 OSD。对部署工具(如

ceph-volume和cephadm)进行限制,以便在引导 OSD 时具有添加密钥的权限。 配置集 bootstrap-mds, 描述-

这仅适用于 Ceph Monitor。授予用户引导元数据服务器的权限。对部署工具(如

cephadm)进行限制,以便在引导元数据服务器时具有添加密钥的权限。 配置集 bootstrap-rbd, 描述-

这仅适用于 Ceph Monitor。授予用户权限来引导 RBD 用户。对部署工具(如

cephadm)进行限制,以便在引导 RBD 用户时具有添加密钥的权限。 配置集 bootstrap-rbd-mirror, 描述-

这仅适用于 Ceph Monitor。授予用户引导

rbd-mirror守护进程用户的用户权限。对部署工具(如cephadm)进行限制,以便在引导rbd-mirror守护进程时具有添加密钥的权限。 profile rbd, 描述-

这适用于 Ceph Monitor、Ceph Manager 和 Ceph OSD。授予用户权限来操作 RBD 镜像。当用作 monitor 上限时,它为用户提供 RBD 客户端应用所需的最小特权;此类特权包括能够阻止其他客户端用户。当用作 OSD 上限时,它提供对指定池的读写访问权限的 RBD 客户端应用程序。Manager cap 支持可选

pool和namespace关键字参数。 profile rbd-mirror, 描述-

这仅适用于 Ceph Monitor。授予用户权限来操作 RBD 镜像并检索 RBD 镜像 config-key secret。它提供了操作

rbd-mirror守护进程所需的最少特权。 profile rbd-read-only, 描述-

这适用于 Ceph 监控器和 Ceph OSD。授予用户对 RBD 镜像的只读权限。Manager cap 支持可选

pool和namespace关键字参数。 profile simple-rados-client, 描述- 这仅适用于 Ceph Monitor。授予用户监控、OSD 和 PG 数据的只读权限。用于直接 librados 客户端应用程序使用。

profile simple-rados-client-with-blocklist, 描述- 这仅适用于 Ceph Monitor。授予用户监控、OSD 和 PG 数据的只读权限。用于直接 librados 客户端应用程序使用。另外,还包括添加块列表条目的权限,以构建高可用性(HA)应用程序。

profile fs-client, 描述- 这仅适用于 Ceph Monitor。授予用户对监控、OSD、PG 和 MDS 数据的只读权限。用于 CephFS 客户端。

配置集 role-definer, 描述- 这适用于 Ceph 监控器和 Auth。授予用户 auth 子系统的所有权限、对 monitor 的只读权限,而不授予任何其他权限。对于自动化工具非常有用。警告:除非自己真正知道您要做的操作,否则不要分配此内容,因为安全状态比较显著且有很大程度。

配置集崩溃, 描述-

这适用于 Ceph 监控器和 Ceph 管理器。授予用户对 monitor 的只读访问权限。与管理器 crash 模块一起使用,将守护进程

崩溃转储上传到监控存储中,以便稍后进行分析。

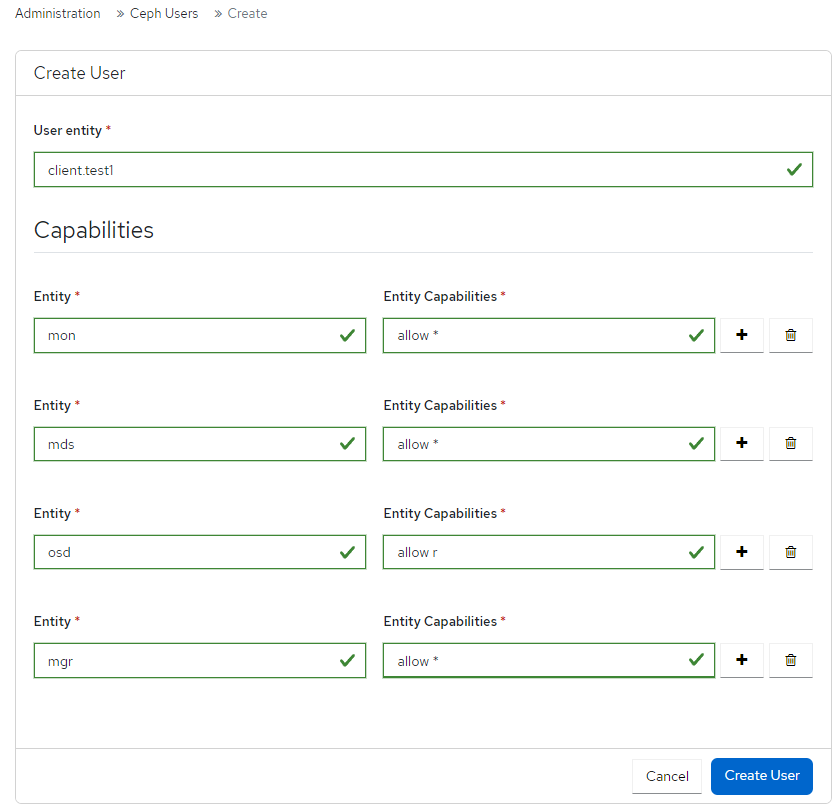

4.6. 创建用户功能

在 Ceph 仪表板上创建具有不同功能的基于角色的访问用户。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 控制面板的管理员级别访问权限。

流程

- 在仪表板导航中,前往 Administration→Ceph Users。

- 点 Create。

在 Create User 表单中,提供以下详情:

-

用户实体 :输入为

TYPE。ID. -

Entity :可以是

mon、mgr、osd或mds。 实体功能 :输入您可以提供给用户的功能。例如,'allow *' 和

profile crash是可分配给客户端的一些功能。注意您可以根据要求向用户添加更多实体。

-

用户实体 :输入为

点 Create User.

通知显示用户创建成功。

4.7. 编辑用户功能

在仪表板中编辑用户或客户端的角色。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 控制面板的管理员级别访问权限。

流程

- 在仪表板导航中,前往 Administration→Ceph Users。

- 选择您要编辑的角色的用户。

- 点 Edit。

在 Edit User 表单中,根据需要编辑 实体 和实体功能。

注意您可以根据要求向用户添加更多实体。

单击 编辑用户。

通知显示用户已被成功编辑。

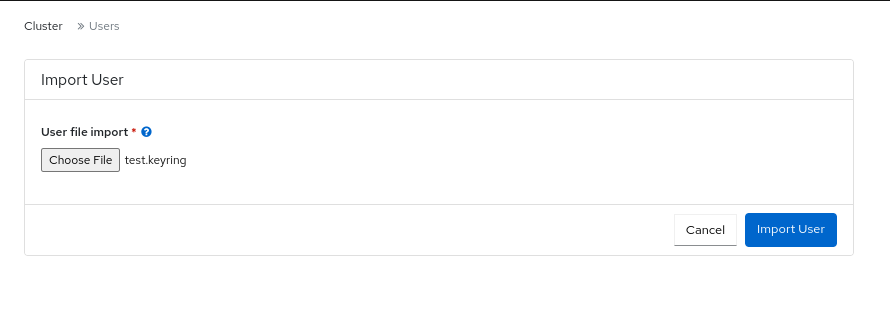

4.8. 导入用户功能

在仪表板上,将用户或客户端的角色从本地主机导入到客户端。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 控制面板的管理员级别访问权限。

流程

在本地主机上创建密钥环文件:

Example

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 在仪表板导航中,前往 Administration→Ceph Users。

- 选择您要导出的角色的用户。

- 选择 Edit→Import。

- 在 Import User 表单中,单击 Choose File。

- 浏览本地主机上的文件并选择.

单击 Import User。

通知显示密钥已被成功导入。

4.9. 导出用户功能

将用户或客户端的角色从仪表板导出到本地主机。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 控制面板的管理员级别访问权限。

流程

- 在仪表板导航中,前往 Administration→Ceph Users。

- 选择您要导出的角色的用户。

- 从操作下拉列表中选择 Export。

从 Ceph 用户导出数据 对话框,单击 Copy to Clipboard。

通知显示密钥被成功复制。

在本地系统中,创建一个密钥环文件并粘贴密钥:

Example

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 单击 Close。

4.10. 删除用户功能

删除仪表板上的用户或客户端的角色。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 控制面板的管理员级别访问权限。

流程

- 在仪表板导航中,前往 Administration→Ceph Users。

- 选择您要删除的用户,然后从操作下拉菜单中选择 Delete。

- 在 Delete user 对话框中,选择 Yes, I am sure。

单击 Delete user。

通知显示用户已被成功删除。

第 5 章 管理 Ceph 守护进程

作为存储管理员,您可以在 Red Hat Ceph Storage 仪表板上管理 Ceph 守护进程。

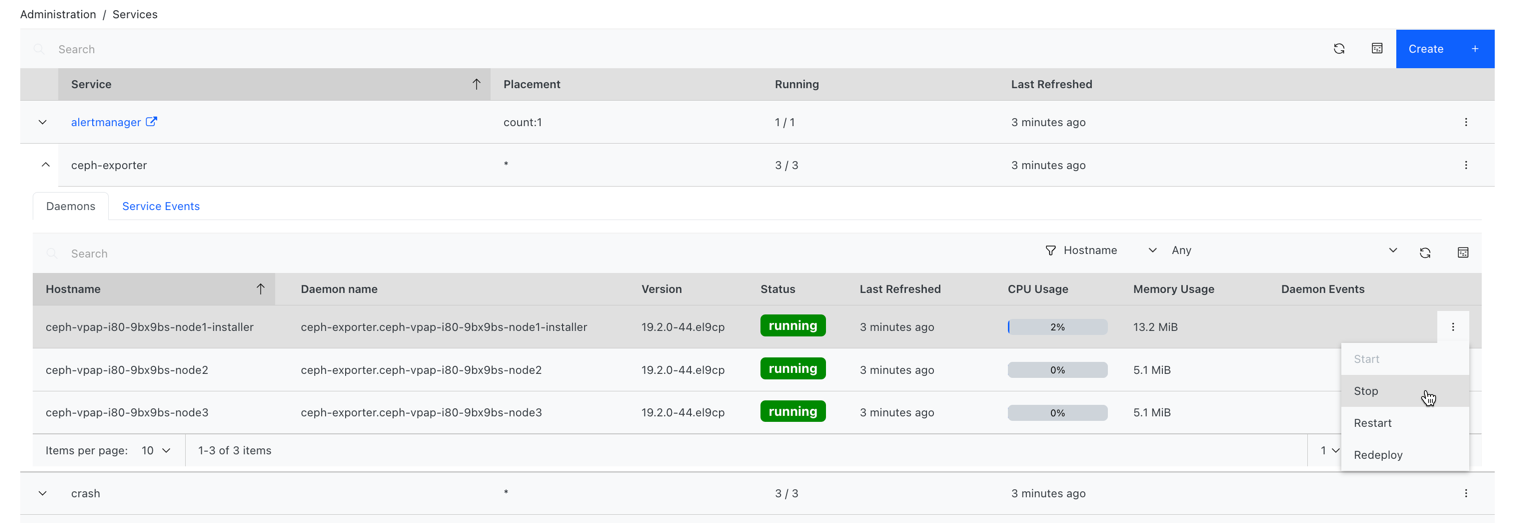

5.1. 守护进程操作

Red Hat Ceph Storage 仪表板允许您启动、停止、重启和重新部署守护进程。

除了监控和管理器守护进程外,所有守护进程都支持这些操作。

先决条件

在开始前,请确保您有以下先决条件:

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 在存储集群中至少配置一个守护进程。

流程

您可以通过两种方式管理守护进程。

在 Services 页面中:

- 在仪表板导航中,前往 Administration→Services。

使用运行该操作的守护进程扩展服务。

注意行可以随时折叠。

在 Daemons 选项卡中,选择守护进程所在的行。

注意可以搜索和过滤 Daemons 表。

选择需要在守护进程上运行的操作。选项为 Start,Stop,Restart, 和 Redeploy。

图 5.1. 从服务管理守护进程

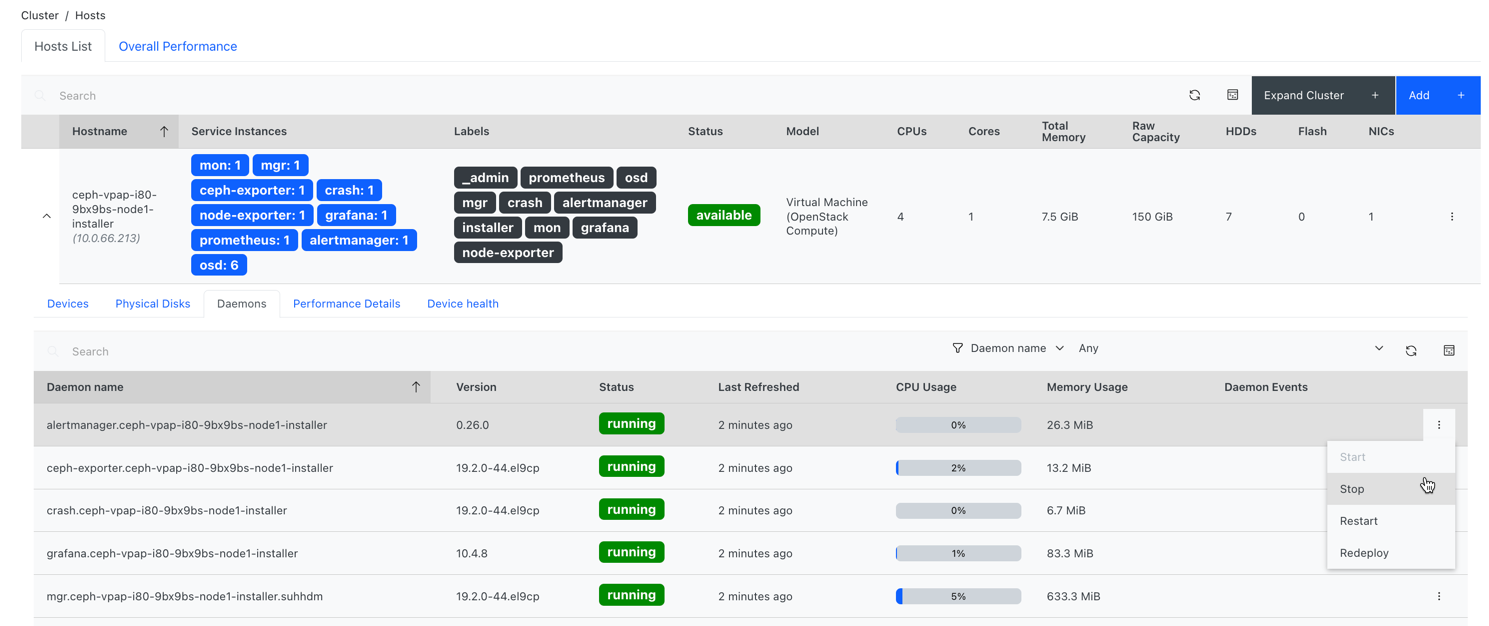

在 Hosts 页面中:

- 在仪表板导航中进入 Cluster→Hosts。

- 在 Hosts List 选项卡上,展开 host 行,再选择守护进程要对其执行操作的主机。

在主机的 Daemons 选项卡中,选择守护进程所在的行。

注意可以搜索和过滤 Daemons 表。

选择需要在守护进程上运行的操作。选项为 Start,Stop,Restart, 和 Redeploy。

图 5.2. 从主机管理守护进程

第 6 章 监控 Ceph 仪表板上的集群

作为存储管理员,您可以使用 Red Hat Ceph Storage Dashboard 根据主机、服务、数据访问方法等来监控集群的特定方面。

本节涵盖了以下管理任务:

- 在仪表板上监控 Ceph 集群的主机。

- 在仪表板上查看和编辑 Ceph 集群的配置。

- 在仪表板上查看和编辑 Ceph 集群的管理器模块。

- 在控制面板中监控 Ceph 集群的监控器。

- 在仪表板中监控 Ceph 集群的服务。

- 监控仪表板上的 Ceph OSD。

- 监控仪表板上的 HAProxy。

- 在控制面板中,查看 Ceph 集群的 CRUSH map。

- 在仪表板上过滤 Ceph 集群的日志。

- 在仪表板上查看 Ceph 集群的集中式日志。

- 在控制面板中监控 Ceph 集群的池。

- 在仪表板中监控 Ceph 文件系统。

- 在控制面板中监控 Ceph 对象网关守护进程。

- 监控 Ceph 控制面板中的块设备镜像。

6.1. 在控制面板中监控 Ceph 集群的主机

您可以在 Red Hat Ceph Storage Dashboard 中监控集群的主机。

以下是主机页面中的不同选项卡。每个标签页包含一个包含 relavent 信息的表。这些表可以按列和行搜索并自定义。

要更改列的顺序,请选择列名称并拖动以在表中放置。

要选择显示哪些列,点切换列 按钮并选择或清除列名称。

在 line selector 字段中输入要显示的行数。

- Devices

- 此选项卡有一个表,它详细说明设备 ID、设备健康状态的状态、生命周期期望、设备名称、预测创建日期以及主机上的守护进程。

- 物理磁盘

- 此选项卡有一个表,详细说明附加到所选主机的所有磁盘,以及它们的类型、大小等。它的详细信息,如设备路径、设备类型、可用、供应商、型号、大小和部署 OSD。要识别哪个磁盘位于物理设备中的位置,请选择设备并点 Identify。选择 LED 应该 blink 的时长,以查找所选磁盘。

- 守护进程

- 此选项卡有一个表,详细说明了在所选主机上部署的所有服务(它们在其中运行的容器),以及它们的当前状态。表的详情,如守护进程名称、守护进程版本、状态、守护进程上次刷新、CPU 使用量、内存用量(以 MiB 为单位)和守护进程事件。守护进程操作可以从此选项卡运行。如需了解更多详细信息,请参阅 守护进程操作。

- 性能详情

- 此选项卡具有部署 OSD 的详细信息,如 OSD 部署、CPU 使用量、网络负载、网络丢弃率和 OSD 磁盘性能统计信息。通过嵌入的 Grafana 仪表板查看性能信息。

- 设备健康状况

- 对于启用了 SMART 的设备,您只能在部署 OSD 的 OSD 上获取单个健康状态和 SMART 数据。

先决条件

在开始前,请确保您有以下先决条件:

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 主机添加到存储集群中。

- 存储集群中部署了所有服务、监控、管理器和 OSD 守护进程。

流程

- 在仪表板导航中进入 Cluster→Hosts。

- 在 Hosts List 选项卡上,展开 host 行,再选择守护进程要对其执行操作的主机。

在主机的 Daemons 选项卡中,选择守护进程所在的行。

注意可以搜索和过滤 Daemons 表。

选择需要在守护进程上运行的操作。选项为 Start,Stop,Restart, 和 Redeploy。

图 6.1. 监控 Ceph 集群的主机

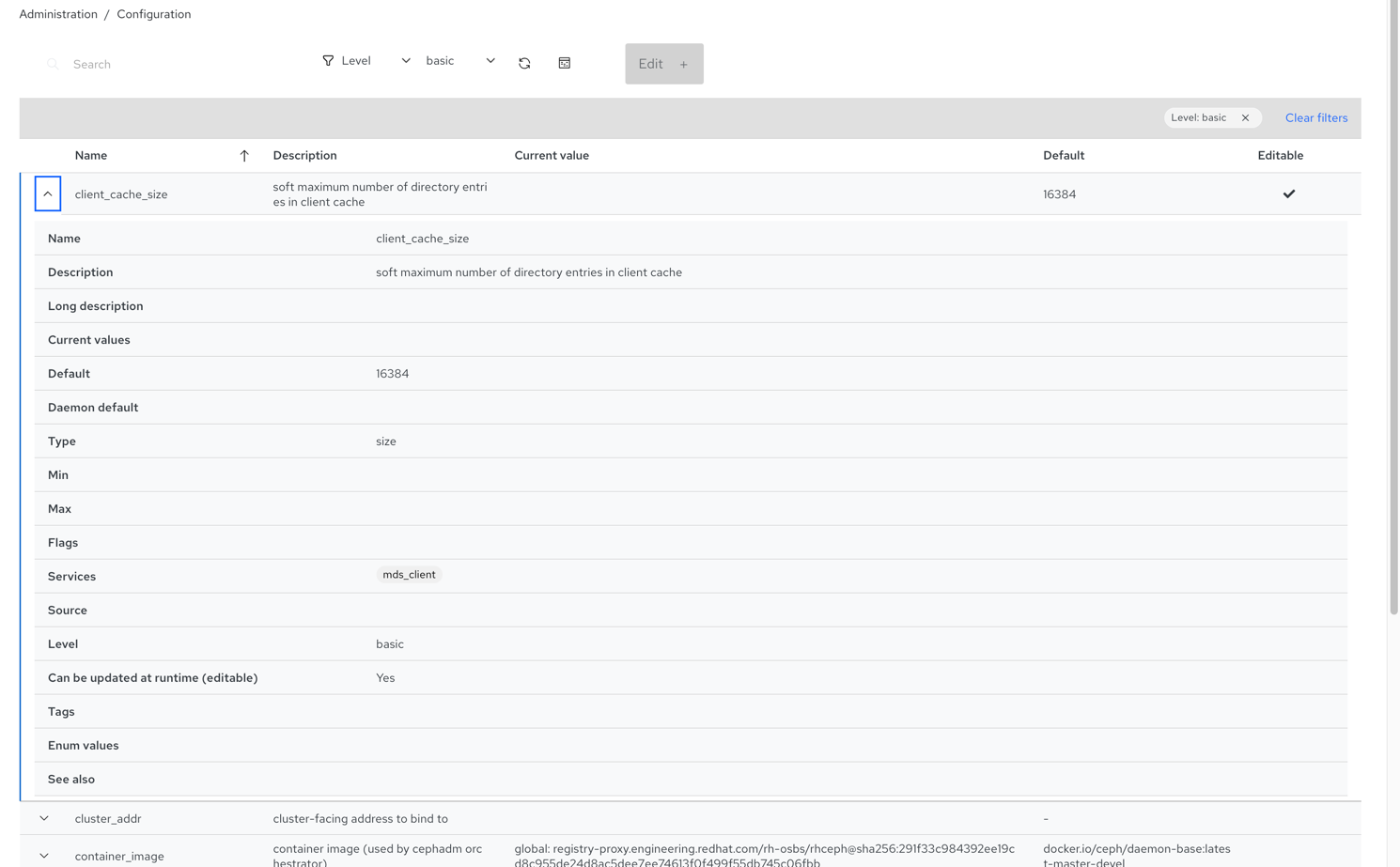

6.2. 在控制面板中查看和编辑 Ceph 集群的配置

您可以在仪表板上查看 Ceph 集群的各种配置选项。您只能编辑一些配置选项。

先决条件

在开始前,请确保您有以下先决条件:

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 所有服务都部署在存储集群中。

流程

- 在仪表板导航中,进入 Administration→Configuration。

要查看配置的详细信息,请展开行内容。

图 6.2. 配置选项

- 可选: 使用搜索字段查找配置。

可选:您可以过滤特定配置。使用以下过滤器:

- level - Basic、advanced 或 dev

- service - Any、mon、mgr、osd、mds、common、mds_client、rgw 和类似的过滤器。

- Source - Any、mon 和类似过滤器

- modified - yes 或 no

要编辑配置,请选择配置行,然后单击 Edit。

使用 Edit 表单编辑所需参数,然后点 Update。

通知显示配置已被成功更新。

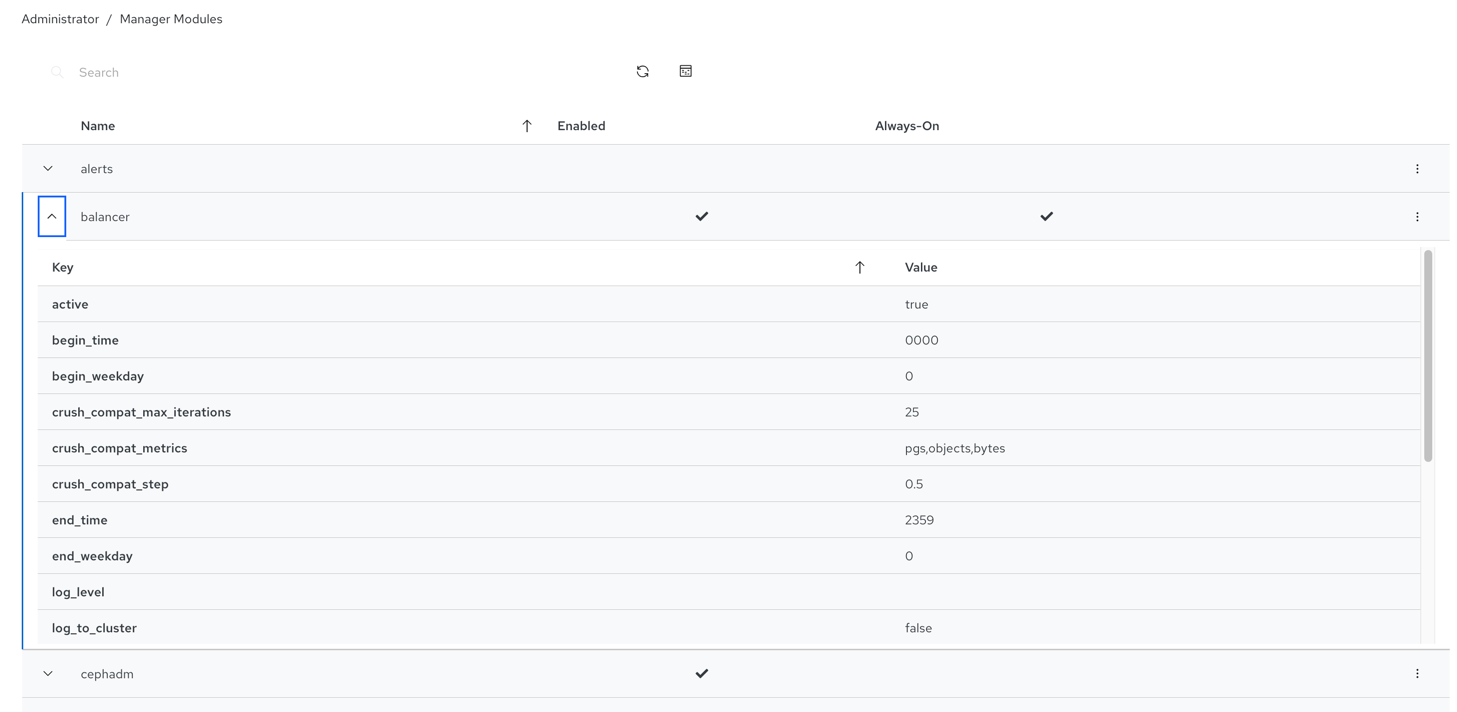

6.3. 在控制面板中查看和编辑 Ceph 集群的管理器模块

管理器模块用于管理模块特定的配置设置。例如,您可以为集群健康启用警报。

您可以在 Red Hat Ceph Storage 仪表板中查看、启用或禁用集群管理器模块。

先决条件

在开始前,请确保您有以下先决条件:

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

查看管理器模块

- 在仪表板导航中,进入 Administration→Manager Modules。

要查看特定管理器模块的详细信息,请展开行内容。

图 6.3. Manager 模块

启用管理器模块

选择行,然后从操作下拉列表中点 Enable。

禁用 manager 模块

选择行,然后从操作下拉列表中点 Disable。

编辑管理器模块

选择行:

注意不是所有模块都有可配置参数。如果模块不可配置,则 Edit 按钮被禁用。

编辑所需参数并点 Update。

通知显示该模块已被成功更新。

6.4. 在控制面板中监控 Ceph 集群的监控

您可以在 Red Hat Ceph Storage 仪表板的登录页面上监控 Ceph 监视器的性能,您也可以在 Monitor 面板中查看 monitor 的详细信息,如状态、仲裁、打开会话数和性能计数器。

先决条件

在开始前,请确保您有以下先决条件:

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 监控器部署在存储集群中。

流程

在仪表板导航中,进入 Cluster→Monitors。

Monitor 面板显示有关总体监控状态和监控处于和 out 仲裁的主机的信息。

要查看打开的会话数量,请在 In Quorum 表中将光标悬停在 Open Sessions 上。

要查看任何 monitor 的性能计数器,请点击 In Quorum 和 Not In Quorum 表中的 Name。

图 6.4. 查看监控性能计数器

6.5. 在控制面板中监控 Ceph 集群的服务

您可以在 Red Hat Ceph Storage Dashboard 中监控集群的服务。您可以查看主机名、守护进程类型、守护进程 ID、容器 ID、容器镜像名称、容器镜像 ID、版本状态以及最后一次刷新的时间等详情。

先决条件

在开始前,请确保您有以下先决条件:

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 主机添加到存储集群中。

- 所有服务都部署在存储集群中。

流程

- 在仪表板导航中,前往 Administration→Services。

展开该服务以获取更多详细信息。

图 6.5. 监控 Ceph 集群的服务

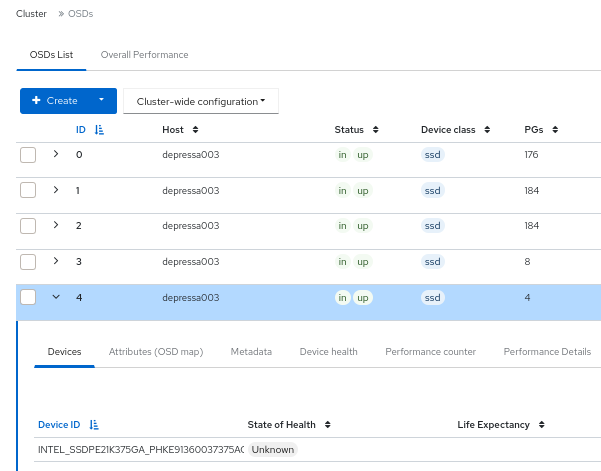

6.6. 监控仪表板上的 Ceph OSD

您可以在 Red Hat Ceph Storage Dashboard 的登录页面中监控 Ceph OSD 的状态。您还可以在 OSD 选项卡中查看主机、状态、设备类、放置组(PG)、大小标志、使用量以及读写操作时间等详情。

以下是 OSD 页面中的不同标签页:

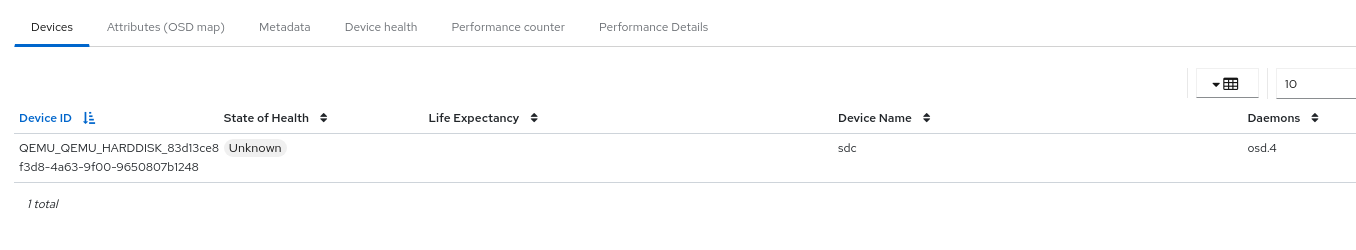

- Devices - 此选项卡的详情,如设备 ID、健康状态、生命周期期望、设备名称和主机上的守护进程。

- Attributes (OSD map) - 此选项卡显示集群地址、心跳、OSD 状态和其他 OSD 属性的详细信息。

- Metadata - 此选项卡显示 OSD 对象存储、设备、操作系统和内核详细信息的详细信息。

- 设备健康状况 - 对于启用了 SMART 的设备,您可以获取单个健康状态和 SMART 数据。

- 性能计数器 - 此选项卡提供了在设备上写入的字节数的详细信息。

- 性能详细信息 - 此选项卡具有部署 OSD 的详细信息,如 OSD 部署、CPU 使用量、网络负载、网络降低率和 OSD 磁盘性能统计信息。通过嵌入的 Grafana 仪表板查看性能信息。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 主机添加到存储集群中。

- 所有服务(包括 OSD)都部署在存储集群中。

流程

- 在仪表板导航中进入 Cluster→OSDs。

要查看特定 OSD 的详细信息,请从 OSD List 选项卡中扩展 OSD 行。

图 6.6. 监控 Ceph 集群的 OSD

您可以通过单击对应的标签页来查看其他详细信息,如 Devices,Attributes (OSD map), Metadata,Device Health,Performance counter, 和 Performance Details。

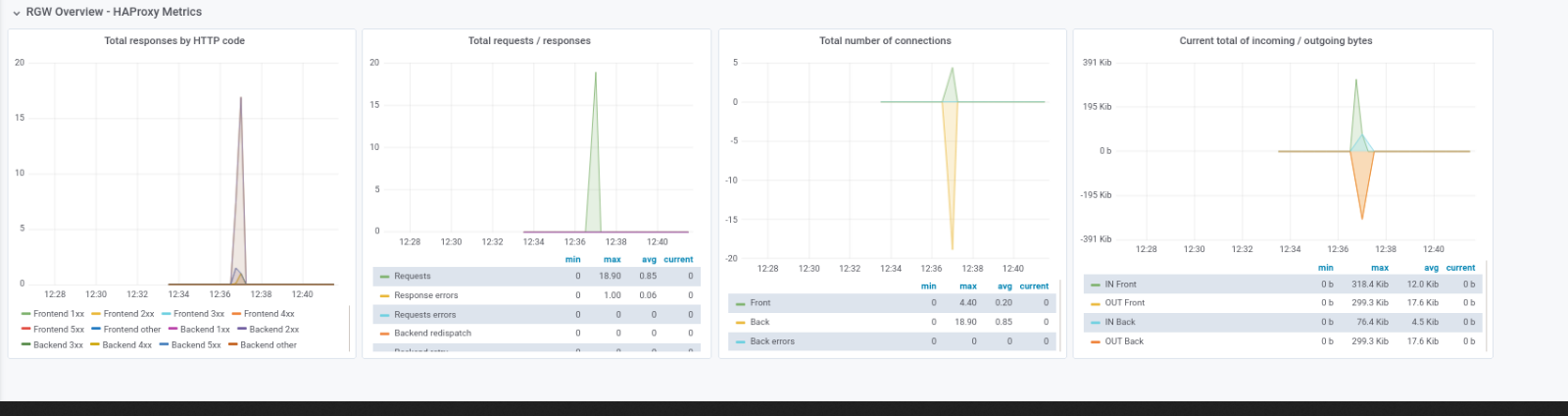

6.7. 监控仪表板上的 HAProxy

Ceph 对象网关允许您为单个区域分配多个对象网关实例,以便随着负载增加而横向扩展。由于每个对象网关实例都有自己的 IP 地址,因此您可以使用 HAProxy 在 Ceph 对象网关服务器之间平衡负载。

您可以在仪表板上监控以下 HAProxy 指标:

- HTTP 代码的总响应。

- 请求/响应总数.

- 连接总数。

- 传入/传出字节的当前总数。

您还可以通过运行 ceph dashboard get-grafana-api-url 命令获取 Grafana 详情。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 存储仪表板上的管理级别访问权限。

- 现有 Ceph 对象网关服务,没有 SSL。如果您希望 SSL 服务,则应在 ingress 服务上配置证书,而不是 Ceph 对象网关服务。

- 使用 Ceph 编排器部署的 Ingress 服务。

- 监控堆栈组件在控制面板上创建。

流程

登录到 Grafana URL 并选择 RGW_Overview 面板:

语法

https://DASHBOARD_URL:3000

https://DASHBOARD_URL:3000Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

https://dashboard_url:3000

https://dashboard_url:3000Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 验证 Grafana URL 上的 HAProxy 指标。

- 在 Ceph 仪表板导航中,进入 Object→Gateways。

在 Overall Performance 选项卡中,验证 Ceph 对象网关 HAProxy 指标。

图 6.7. HAProxy 指标

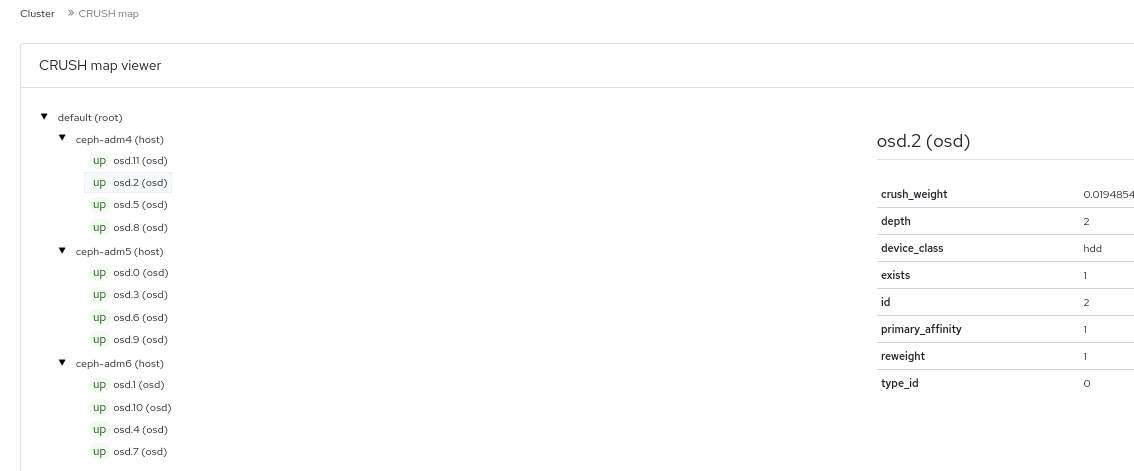

6.8. 在控制面板中查看 Ceph 集群的 CRUSH map

您可以查看包含 OSD 列表以及 Red Hat Ceph Storage 仪表板上相关信息的 CRUSH map。CRUSH map 和 CRUSH 算法一起确定数据的保存方式和位置。控制面板允许您查看 CRUSH map 的不同方面,包括 OSD 主机、OSD 守护进程、ID 号、设备类等。

借助 CRUSH map,您可以确定哪些主机上运行一个特定的 OSD ID。如果 OSD 出现问题,这非常有用。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 存储集群中部署的 OSD 守护进程。

流程

- 从仪表板导航中,转至 Cluster→CRUSH 映射。

若要查看特定 OSD 的详细信息,请点它所在的行。

图 6.8. CRUSH 映射详细视图

6.9. 在控制面板中过滤 Ceph 集群的日志

您可以根据以下标准,查看和过滤 Red Hat Ceph Storage 集群的日志。条件包括 Priority, Keyword, Date, 和 Time range.

您可以将日志下载到系统中,或者将日志复制到剪贴板,以进行进一步分析。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 由于 Ceph Monitor 是最近一次启动,因此已生成了日志条目。

控制面板日志记录功能仅显示三十最新高级别事件。事件通过 Ceph 监控存储在内存中。重启 monitor 后的条目会消失。如果您需要查看详细或旧的日志,请参阅基于文件的日志。

流程

- 在仪表板导航中,进入 Observability→Logs。

在 Cluster Logs 选项卡中查看集群日志。

图 6.9. 集群日志

- 使用 Priority 过滤器按 Debug、Info、Warning、Error 或 All 过滤。

- 使用 Keyword 字段输入文本,以按关键字进行搜索。

- 使用 Date picker 根据特定日期过滤。

-

使用 Time range 字段输入范围,使用 HH:MM - HH:MM 格式。小时需要是数字

0到23。 - 要组合过滤器,请设置两个或多个过滤器。

- 要保存日志,请使用 Download 或 Copy to Clipboard 按钮。

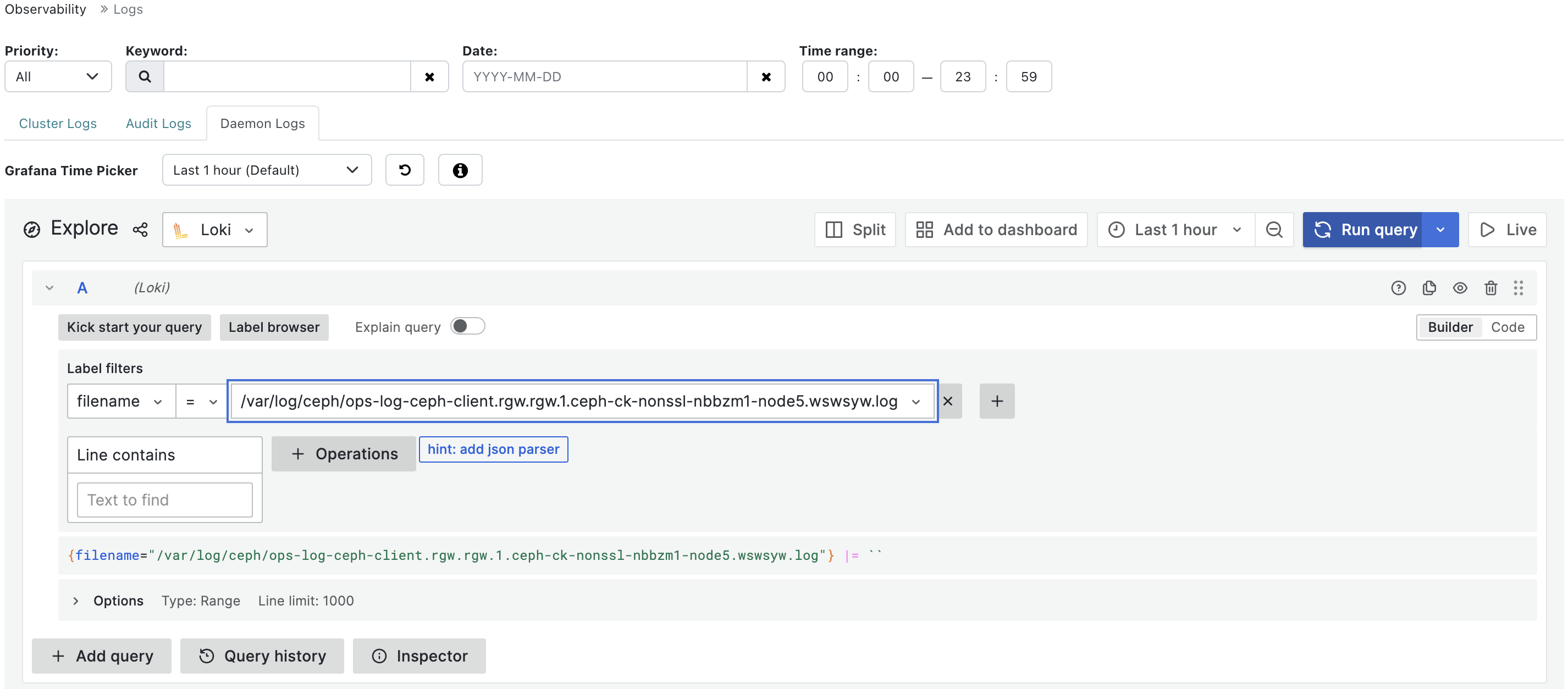

6.10. 在控制面板中查看 Ceph 集群的集中式日志

Ceph 控制面板允许您查看 Red Hat Ceph Storage 集群中集中空间中所有客户端的日志,以便有效地监控。这可以通过使用 Loki 来实现,这是一个旨在存储和查询日志的日志聚合系统,以及 Promtail 是一个将本地日志内容发送到私有 Grafana Loki 实例的代理。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- Grafana 配置并在集群中登录。

流程

- 在仪表板导航中,前往 Administration→Services。

- 在 Services 中,单击 Create。

-

在 Create Service 表单中,从 Type 列表中选择

loki。填写剩余的详细信息,然后单击 创建服务。 重复上述步骤,以创建

Promtail服务。从 Type 列表中选择promtail。成功创建后,在 Services 表中会显示

loki和promtail服务。图 6.10. 创建 Loki 和 Promtail 服务

注意默认情况下,Promtail 服务部署到所有正在运行的主机上。

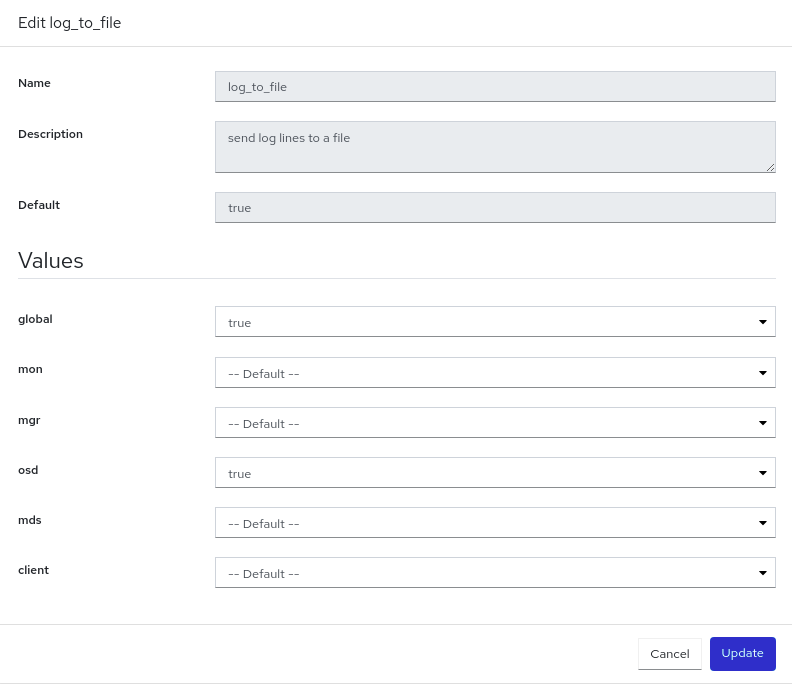

启用记录到文件。

- 进入 Administration→Configuration。

-

选择

log_to_file,然后单击 Edit。 在 Edit log_to_file 表单中,将 global 值设为

true。图 6.11. 配置日志文件

点 Update。

显示

Updated 配置选项 log_to_file通知,并返回到 Configuration 表。对

mon_cluster_log_to_file重复这些步骤,将全局 值设置为true。注意需要配置

log_to_file和mon_cluster_log_to_file文件。

可选 : 要查看 Ceph 对象网关 'ops_log',必须使用以下命令将

rgw_enable_ops_log设置为true:ceph config set client.rgw rgw_enable_ops_log true

$ ceph config set client.rgw rgw_enable_ops_log trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要从仪表板进行此操作,请按照以下步骤执行:

- 进入 Administration → Configuration。

- 将 level 从 'basic' 更改为 'Dev'。

-

搜索

rgw_enable_ops_log,并将值编辑为true。 -

接下来,在 Daemon Logs 选项卡下,在

filename字段找到日志文件,并运行查询来查看 ops 日志。

要查看集中式日志,请转至 Observability→Logs 并切换到 Daemon Logs 选项卡。使用 Log 浏览器 选择文件,然后单击 Show logs 以查看该文件中的日志。

图 6.12. 查看集中式日志

6.11. 在控制面板中监控 Ceph 集群的池

您可以在 Red Hat Ceph Storage Dashboard 中查看集群中池的详情、性能详情、配置和整体性能。

池在 Ceph 存储集群分发和存储数据的方式中发挥着重要作用。如果您在不创建池的情况下部署了集群,Ceph 将使用默认池来存储数据。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 创建池

流程

- 在仪表板导航中,进入 Cluster→Pools。

- 查看 池列表 选项卡,其中提供了数据保护的详细信息以及池所启用的应用程序。对于所需详情,将鼠标悬停在 Usage、Read bytes 和 Write bytes 上。

展开池行以获取有关特定池的详细信息。

图 6.13. 监控池

- 有关常规信息,请转至 Overall Performance 选项卡。

6.12. 监控仪表板上的 Ceph 文件系统

您可以使用 Red Hat Ceph Storage 控制面板监控 Ceph 文件系统(CephFS)和相关组件。

对于列出的每个文件系统,有以下标签:

- 详情

- 查看元数据服务器(MDS)及其等级以及任何备用守护进程、池及其用法,以及性能计数器。

- 目录

- 查看目录、配额和快照列表。选择一个目录来设置和取消设置最大文件和大小配额,并为特定的目录创建和删除快照。

- 子卷

- 创建、编辑和查看子卷信息。它们可以按子卷组过滤。

- 子卷组

- 创建、编辑和查看子卷组信息。

- 快照

- 创建、克隆和查看快照信息。它们可以根据子卷组和子卷进行过滤。

- 快照调度

- 启用、创建、编辑和删除快照调度。

- 客户端

- 查看和驱除 Ceph 文件系统客户端信息。

- 性能详情

- 通过嵌入的 Grafana 仪表板查看文件系统的性能。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- MDS 服务至少部署在其中一个主机上。

- 已安装 Ceph 文件系统。

流程

- 在仪表板导航中进入 File→File Systems。

- 要查看有关单个文件系统的更多信息,请展开文件系统行。

6.13. 在控制面板中监控 Ceph 对象网关守护进程

您可以使用 Red Hat Ceph Storage 控制面板监控 Ceph 对象网关守护进程。您可以查看 Ceph 对象网关守护进程的详情、性能计数器和性能详情。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 在存储集群中至少配置一个 Ceph 对象网关守护进程。

流程

- 在仪表板导航中,进入 Object→Gateways。

- 从 Gateways List 选项卡查看单个网关的信息。

- 要查看有关单个网关的更多信息,请展开网关行。

- 如果您配置了多个 Ceph 对象网关守护进程,点 Sync Performance 选项卡并查看多站点性能计数器。

6.14. 监控 Ceph 仪表板上的块设备镜像

您可以使用 Red Hat Ceph Storage 控制面板监控和管理块设备镜像。您可以查看镜像的详情、快照、配置详情和性能详情。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 创建启用了 rbd 应用的池。

- 已创建一个镜像。

流程

- 在仪表板导航中,进入 Block→Images。

展开镜像行以查看详细信息。

图 6.14. 监控块设备镜像

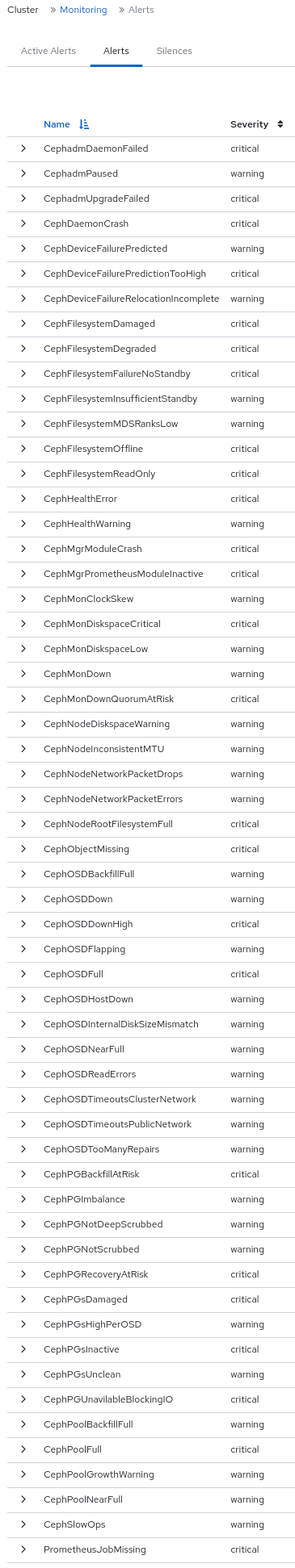

第 7 章 在 Ceph 仪表板上管理警报

作为存储管理员,您可以查看警报详情并在 Red Hat Ceph Storage 仪表板中为它们创建静默。这包括以下预定义警报:

- CephadmDaemonFailed

- CephadmPaused

- CephadmUpgradeFailed

- CephDaemonCrash

- CephDeviceFailurePredicted

- CephDeviceFailurePredictionTooHigh

- CephDeviceFailureRelocationIncomplete

- CephFilesystemDamaged

- CephFilesystemDegraded

- CephFilesystemFailureNoStandby

- CephFilesystemInsufficientStandby

- CephFilesystemMDSRanksLow

- CephFilesystemOffline

- CephFilesystemReadOnly

- CephHealthError

- CephHealthWarning

- CephMgrModuleCrash

- CephMgrPrometheusModuleInactive

- CephMonClockSkew

- CephMonDiskspaceCritical

- CephMonDiskspaceLow

- CephMonDown

- CephMonDownQuorumAtRisk

- CephNodeDiskspaceWarning

- CephNodeInconsistentMTU

- CephNodeNetworkPacketDrops

- CephNodeNetworkPacketErrors

- CephNodeRootFilesystemFull

- CephObjectMissing

- CephOSDBackfillFull

- CephOSDDown

- CephOSDDownHigh

- CephOSDFlapping

- CephOSDFull

- CephOSDHostDown

- CephOSDInternalDiskSizeMismatch

- CephOSDNearFull

- CephOSDReadErrors

- CephOSDTimeoutsClusterNetwork

- CephOSDTimeoutsPublicNetwork

- CephOSDTooManyRepairs

- CephPGBackfillAtRisk

- CephPGImbalance

- CephPGNotDeepScrubbed

- CephPGNotScrubbed

- CephPGRecoveryAtRisk

- CephPGsDamaged

- CephPGsHighPerOSD

- CephPGsInactive

- CephPGsUnclean

- CephPGUnavilableBlockingIO

- CephPoolBackfillFull

- CephPoolFull

- CephPoolGrowthWarning

- CephPoolNearFull

- CephSlowOps

- PrometheusJobMissing

图 7.1. 预定义的警报

您还可以使用简单网络管理协议(SNMP)陷阱来监控警报。

7.1. 启用监控堆栈

您可以使用命令行界面手动启用 Red Hat Ceph Storage 集群的监控堆栈,如 Prometheus、Alertmanager 和 Grafana。

您可以使用 Prometheus 和 Alertmanager API 来管理警报和静默。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 对所有主机的根级别访问权限。

流程

登录

cephadmshell:示例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow 为监控堆栈设置 API:

指定 Alertmanager 服务器的主机和端口:

语法

ceph dashboard set-alertmanager-api-host ALERTMANAGER_API_HOST:PORT

ceph dashboard set-alertmanager-api-host ALERTMANAGER_API_HOST:PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph dashboard set-alertmanager-api-host http://10.0.0.101:9093 Option ALERTMANAGER_API_HOST updated

[ceph: root@host01 /]# ceph dashboard set-alertmanager-api-host http://10.0.0.101:9093 Option ALERTMANAGER_API_HOST updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要查看配置的警报,请将 URL 配置为 Prometheus API。使用此 API 时,Ceph 控制面板 UI 会验证新静默是否与对应的警报匹配。

语法

ceph dashboard set-prometheus-api-host PROMETHEUS_API_HOST:PORT

ceph dashboard set-prometheus-api-host PROMETHEUS_API_HOST:PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph dashboard set-prometheus-api-host http://10.0.0.101:9095 Option PROMETHEUS_API_HOST updated

[ceph: root@host01 /]# ceph dashboard set-prometheus-api-host http://10.0.0.101:9095 Option PROMETHEUS_API_HOST updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 设置主机后,刷新浏览器的仪表板窗口。

指定 Grafana 服务器的主机和端口:

语法

ceph dashboard set-grafana-api-url GRAFANA_API_URL:PORT

ceph dashboard set-grafana-api-url GRAFANA_API_URL:PORTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

[ceph: root@host01 /]# ceph dashboard set-grafana-api-url https://10.0.0.101:3000 Option GRAFANA_API_URL updated

[ceph: root@host01 /]# ceph dashboard set-grafana-api-url https://10.0.0.101:3000 Option GRAFANA_API_URL updatedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

获取 Prometheus、Alertmanager 和 Grafana API 主机详情:

示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 可选: 如果您在 Prometheus、Alertmanager 或 Grafana 设置中使用自签名证书,请在仪表板中禁用证书验证,这样可避免拒绝由未知证书颁发机构(CA)签名的证书导致的连接,或者与主机名不匹配。

对于 Prometheus:

示例

[ceph: root@host01 /]# ceph dashboard set-prometheus-api-ssl-verify False

[ceph: root@host01 /]# ceph dashboard set-prometheus-api-ssl-verify FalseCopy to Clipboard Copied! Toggle word wrap Toggle overflow 对于 Alertmanager:

示例

[ceph: root@host01 /]# ceph dashboard set-alertmanager-api-ssl-verify False

[ceph: root@host01 /]# ceph dashboard set-alertmanager-api-ssl-verify FalseCopy to Clipboard Copied! Toggle word wrap Toggle overflow 对于 Grafana:

示例

[ceph: root@host01 /]# ceph dashboard set-grafana-api-ssl-verify False

[ceph: root@host01 /]# ceph dashboard set-grafana-api-ssl-verify FalseCopy to Clipboard Copied! Toggle word wrap Toggle overflow

获取 Prometheus、Alertmanager 和 Grafana 的自签名证书验证设置详情:

示例

[ceph: root@host01 /]# ceph dashboard get-prometheus-api-ssl-verify [ceph: root@host01 /]# ceph dashboard get-alertmanager-api-ssl-verify [ceph: root@host01 /]# ceph dashboard get-grafana-api-ssl-verify

[ceph: root@host01 /]# ceph dashboard get-prometheus-api-ssl-verify [ceph: root@host01 /]# ceph dashboard get-alertmanager-api-ssl-verify [ceph: root@host01 /]# ceph dashboard get-grafana-api-ssl-verifyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:如果仪表板没有反映更改,则必须禁用并启用仪表板:

示例

[ceph: root@host01 /]# ceph mgr module disable dashboard [ceph: root@host01 /]# ceph mgr module enable dashboard

[ceph: root@host01 /]# ceph mgr module disable dashboard [ceph: root@host01 /]# ceph mgr module enable dashboardCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2. 配置 Grafana 证书

cephadm 使用 ceph key/value 存储中定义的证书部署 Grafana。如果没有指定证书,cephadm 会在部署 Grafana 服务的过程中生成自签名证书。

您可以使用 ceph config-key set 命令配置自定义证书。

cephadm 证书只更新单个 Grafana 实例。

由于一个已知问题,在使用多个 Grafana 实例时,请使用 update_grafana_cert.py 脚本以及 红帽客户门户网站上的 RHCS 7 升级后不使用自定义 grafana 证书 的说明。

在更改 Grafana 放置(如将守护进程移到另一主机)时,必须再次运行脚本来生成证书。

前提条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

流程

登录

cephadmshell:示例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow 为 Grafana 配置自定义证书:

示例

[ceph: root@host01 /]# ceph config-key set mgr/cephadm/grafana_key -i $PWD/key.pem [ceph: root@host01 /]# ceph config-key set mgr/cephadm/grafana_crt -i $PWD/certificate.pem

[ceph: root@host01 /]# ceph config-key set mgr/cephadm/grafana_key -i $PWD/key.pem [ceph: root@host01 /]# ceph config-key set mgr/cephadm/grafana_crt -i $PWD/certificate.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果已经部署了 Grafana,请运行

reconfig以更新配置:示例

[ceph: root@host01 /]# ceph orch reconfig grafana

[ceph: root@host01 /]# ceph orch reconfig grafanaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 每次添加新证书时,请按照以下步骤执行:

创建新目录

示例

mkdir /root/internalca cd /root/internalca

[root@host01 ~]# mkdir /root/internalca [root@host01 ~]# cd /root/internalcaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 生成密钥:

示例

openssl ecparam -genkey -name secp384r1 -out $(date +%F).key

[root@host01 internalca]# openssl ecparam -genkey -name secp384r1 -out $(date +%F).keyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 查看密钥:

示例

openssl ec -text -in $(date +%F).key | less

[root@host01 internalca]# openssl ec -text -in $(date +%F).key | lessCopy to Clipboard Copied! Toggle word wrap Toggle overflow 发出请求:

示例

umask 077; openssl req -config openssl-san.cnf -new -sha256 -key $(date +%F).key -out $(date +%F).csr

[root@host01 internalca]# umask 077; openssl req -config openssl-san.cnf -new -sha256 -key $(date +%F).key -out $(date +%F).csrCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在向签名发送请求前查看请求:

示例

openssl req -text -in $(date +%F).csr | less

[root@host01 internalca]# openssl req -text -in $(date +%F).csr | lessCopy to Clipboard Copied! Toggle word wrap Toggle overflow 作为 CA 签名:

示例

openssl ca -extensions v3_req -in $(date +%F).csr -out $(date +%F).crt -extfile openssl-san.cnf

[root@host01 internalca]# openssl ca -extensions v3_req -in $(date +%F).csr -out $(date +%F).crt -extfile openssl-san.cnfCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查签名证书:

示例

openssl x509 -text -in $(date +%F).crt -noout | less

[root@host01 internalca]# openssl x509 -text -in $(date +%F).crt -noout | lessCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3. 添加 Alertmanager Webhook

您可以向现有 Alertmanager 配置添加新 webhook,以接收有关存储集群运行状况的实时警报。您必须启用传入的 webhook,以允许将消息异步到第三方应用程序中。

例如,如果一个 OSD 在 Red Hat Ceph Storage 集群中停机,您可以将 Alertmanager 配置为在 Google chat 上发送通知。

前提条件

- 正在运行的 Red Hat Ceph Storage 集群启用了监控堆栈组件。

- 在接收第三方应用程序上配置的传入 Webhook。

流程

登录

cephadmshell:示例

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将 Alertmanager 配置为使用 Webhook 进行通知:

语法

service_type: alertmanager spec: user_data: default_webhook_urls: - "_URLS_"service_type: alertmanager spec: user_data: default_webhook_urls: - "_URLS_"Copy to Clipboard Copied! Toggle word wrap Toggle overflow default_webhook_urls是添加到默认接收器webhook_configs配置中的额外 URL 列表。示例

service_type: alertmanager spec: user_data: webhook_configs: - url: 'http:127.0.0.10:8080'service_type: alertmanager spec: user_data: webhook_configs: - url: 'http:127.0.0.10:8080'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 更新 Alertmanager 配置:

示例

[ceph: root@host01 /]# ceph orch reconfig alertmanager

[ceph: root@host01 /]# ceph orch reconfig alertmanagerCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

从 Alertmanager 到 Gchat 的通知示例:

示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4. 在 Ceph 仪表板上查看警报

触发警报后,您可以在 Red Hat Ceph Storage 控制面板查看它。您可以编辑 Manager 模块 设置,以便在触发警报时触发邮件。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 配置了运行简单邮件传输协议(SMTP)。

- 发出的警报。

流程

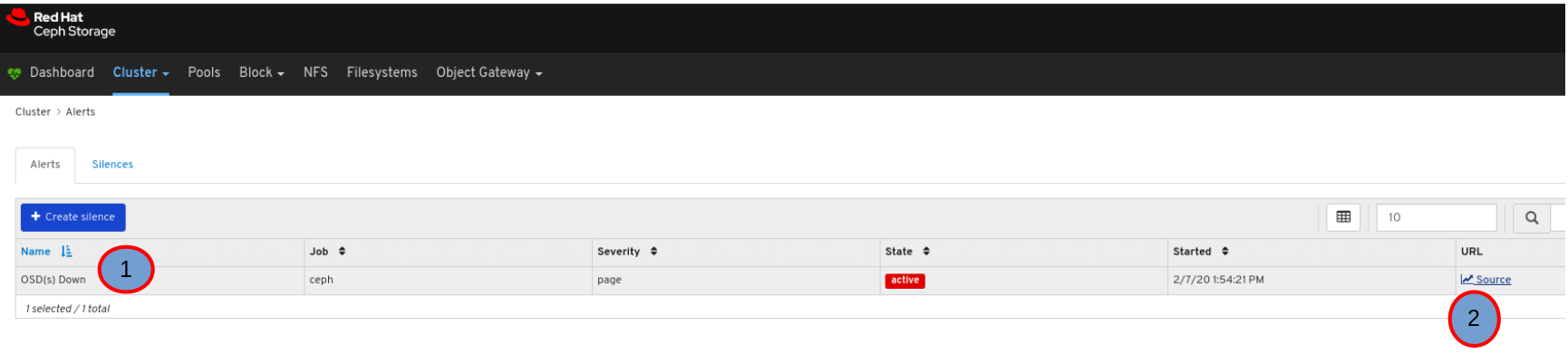

- 在仪表板导航中,进入 Observability→Alerts。

- 从 Active Alerts 选项卡中查看活跃的 Prometheus 警报。

从 Alerts 选项卡中查看所有警报。

要查看警报详情,请展开警报行。

要查看警报的来源,请单击其行,然后单击 Source。

7.5. 在 Ceph 仪表板上创建静默

您可以在 Red Hat Ceph Storage 仪表板中针对指定时间为警报创建静默。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 触发警报。

流程

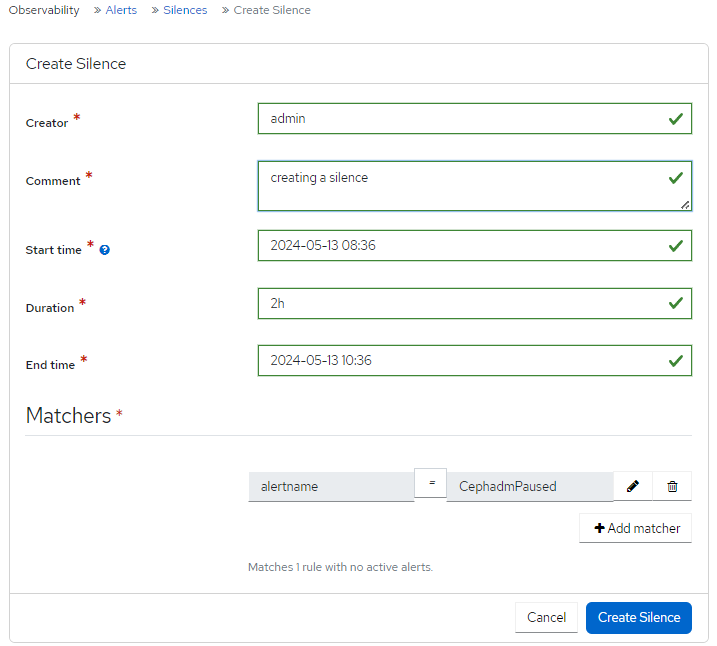

- 在仪表板导航中,进入 Observability→Alerts。

- 在 Silences 选项卡上,单击 Create。

在 Create Silence 表单中,填写所需字段。

使用 Add matcher 添加静默要求。

图 7.2. 创建静默

点击 Create Silence。

通知显示静默创建成功,以及 Silences 表中的 Alerts Silenced 更新。

7.6. 在 Ceph 仪表板上重新创建静默

您可以在 Red Hat Ceph Storage Dashboard 上的静默中重新创建静默。

前提条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 触发警报。

- 为警报创建的静默。

流程

- 在仪表板导航中,进入 Observability→Alerts。

- 在 Silences 选项卡中,选择包含您要重新创建的警报的行,然后从操作下拉列表中点 Recreate。

编辑任何需要的详情,点 Recreate Silence 按钮。

通知显示表示静默被成功编辑,静默的状态现在为。

7.7. 在 Ceph 仪表板上编辑静默

您可以编辑活跃的静默,例如在 Red Hat Ceph Storage 仪表板中扩展它处于活跃状态的时间。如果静默已到期,可以重新创建静默或为警报创建新静默。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 触发警报。

- 为警报创建的静默。

流程

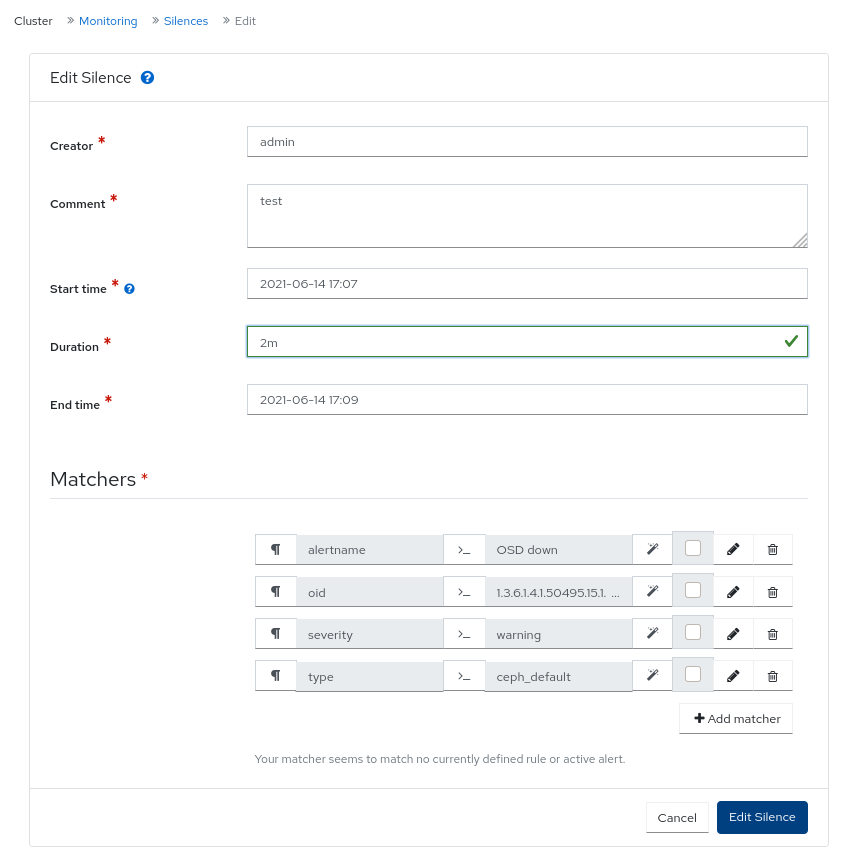

- 登录到仪表板。

- 在导航菜单中点 Cluster。

- 从下拉菜单中选择 Monitoring。

- 点 Silences 选项卡。

- 要编辑静默,请点击它的行。

- 在 Edit 下拉菜单中,选择 Edit。

在 Edit Silence 窗口中,更新详情并点 Edit Silence。

图 7.3. 编辑静默

- 您会收到成功更新静默的通知。

7.8. 在 Ceph 仪表板中将静默设置为过期

您可以使静默到期,以便在 Red Hat Ceph Storage 仪表板中不隐藏匹配的警报。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 触发警报。

- 为警报创建的静默。

流程

- 在仪表板导航中,进入 Observability→Alerts。

- 在 Silences 选项卡中,选择包含您要过期警报的行,然后从操作下拉列表中点 Expire。

在 Expire Silence 通知中,选择 Yes, I am sure 并点 Expire Silence。

通知显示,表示静默成功过期,且警报的 Status 在 Silences 表中 过期。

第 8 章 在 Ceph 仪表板上管理池

作为存储管理员,您可以在 Red Hat Ceph Storage 仪表板上创建、编辑和删除池。

本节涵盖了以下管理任务:

8.1. 在 Ceph 仪表板上创建池

当您在没有创建池的情况下部署存储集群时,Ceph 将使用默认池来存储数据。您可以在 Red Hat Ceph Storage 仪表板中创建一个池来对存储对象进行逻辑分区。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

流程

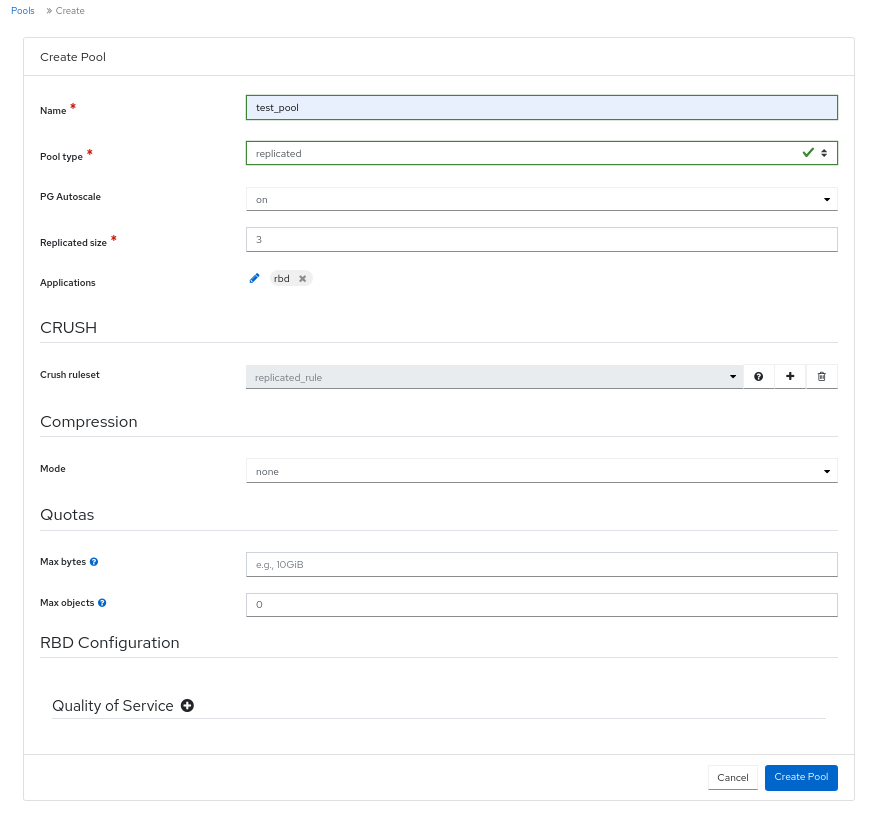

- 在仪表板导航中,进入 Cluster→Pools。

- 点 Create。

填写 Create Pool 表单。

图 8.1. 创建池

注意表单的变化基于选择。并非所有字段都是必需的。

- 设置池的名称,然后选择池类型。

-

选择 池类型,可以是

replicated或erasure。纠删代码称为 Erasure Coded (EC)。 -

可选:如果 PG Autoscale 处于、

off或warn,则选择。 - 可选:如果使用复制池类型,请设置复制的大小。

- 可选:如果使用 EC 池类型,请配置以下附加设置。

- 可选: 要查看当前所选 EC 配置集的设置,请点问号。

- 可选:点加号符号添加新 EC 配置集。

- 可选:点击铅笔图标为池选择应用程序。

- 可选:设置 CRUSH 规则(如果适用)。

- 可选:如果需要压缩,请选择 passive, aggressive, 或 force。

- 可选:设置配额。

- 可选:设置服务质量配置。

要保存更改并完成池创建,请单击 Create Pool。

通知显示池创建成功。

8.2. 在 Ceph 仪表板中编辑池

您可以编辑 Red Hat Ceph Storage 仪表板中的池。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 已创建一个池。

流程

- 在仪表板导航中,进入 Cluster→Pools。

- 要编辑池,请选择池行,再单击 Edit。

- 在 Edit Pool 表单中,编辑所需的参数。

点 Edit Pool 保存更改。

通知显示池已被成功更新。

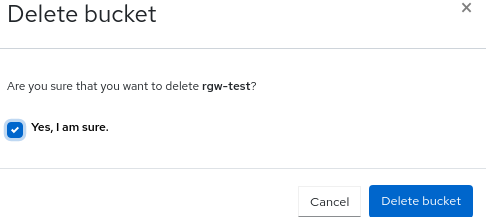

8.3. 删除 Ceph 仪表板上的池

您可以删除 Red Hat Ceph Storage 仪表板中的池。在 Manager 模块中,确保将 mon_allow_pool_delete 的值设为 True。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 已创建一个池。

流程

- 在仪表板导航中,进入 Administration→Configuration。

从 Configuration 表中,选择

mon_allow_pool_delete,然后单击 Edit。注意如果需要,请清除过滤器并搜索配置。

- 从 Edit mon_allow_pool_delete 表单(在 Values 中),将所有值设置为 true。

点 Update。

通知显示配置已被成功更新。

- 进入 Cluster→Pools。

- 选择要删除的池,然后从操作下拉菜单中选择 Delete。

在 Delete Pool 对话框中,通过单击 Delete Pool 选择 Yes, I am sure. and complete。

通知显示池已被成功删除。

第 9 章 管理 Ceph 仪表板上的主机

作为存储管理员,您可以在 Red Hat Ceph Storage Dashboard 中为主机启用或禁用维护模式。维护模式可确保关闭主机来执行维护活动,不会损害集群。

您还可以使用 Red Hat Ceph Storage Dashboard 中的 Start Drain 和 Remove 选项删除主机。

本节涵盖了以下管理任务:

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 主机、Ceph 监控和 Ceph 管理器守护进程添加到存储集群中。

9.1. 进入维护模式

在 Red Hat Ceph Storage Dashboard 上关机之前,您可以进入主机进入维护模式。如果维护模式成功启用,则主机将会脱机,且执行维护活动的任何错误。如果维护模式失败,这表明失败的原因和在关闭主机前需要执行的操作。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 所有其他预备性检查都由 Ceph 在内部执行,并且 Ceph 内部获取任何可能的错误。

流程

- 在仪表板导航中进入 Cluster→Hosts。

选择要进入维护模式的主机,然后从操作下拉菜单中选择 Enter Maintenance。

注意如果主机包含 Ceph 对象网关(RGW)守护进程,则会显示删除 RGW 守护进程的警告可能会导致客户端丢失连接。单击 Continue 以进入维护。

注意当主机进入维护模式时,所有守护进程都会停止。通过扩展主机视图并切换到 Daemons 选项卡,检查主机守护进程的状态。

通知显示主机已被成功移到 maintance。

验证

Maintenance标签显示在 Host 表的 Status 列中。注意如果维护模式失败,则会显示通知,指示失败的原因。

9.2. 退出维护模式

要重启主机,您可以在 Red Hat Ceph Storage Dashboard 上移出维护模式。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 所有其他预备性检查都由 Ceph 在内部执行,并且 Ceph 内部获取任何可能的错误。

流程

- 在仪表板导航中进入 Cluster→Hosts。

选择当前处于维护模式的主机,然后从操作下拉菜单中选择 Exit Maintenance。

注意通过检查 Host 表中的 Status 列中的

Maintenance 标签来识别哪个主机处于维护状态。通知显示主机已成功移出维护。

-

在主机上创建所需的服务。默认情况下,会部署

crash和node-exporter。

验证

-

Maintenance标签已从 Host 表的 Status 列中删除。

9.3. 使用 Ceph 控制面板删除主机

要从 Ceph 集群中删除主机,您可以在 Red Hat Ceph Storage Dashboard 中使用 Start Drain 和 Remove 选项。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 所有其他预备性检查都由 Ceph 在内部执行,并且 Ceph 内部获取任何可能的错误。

流程

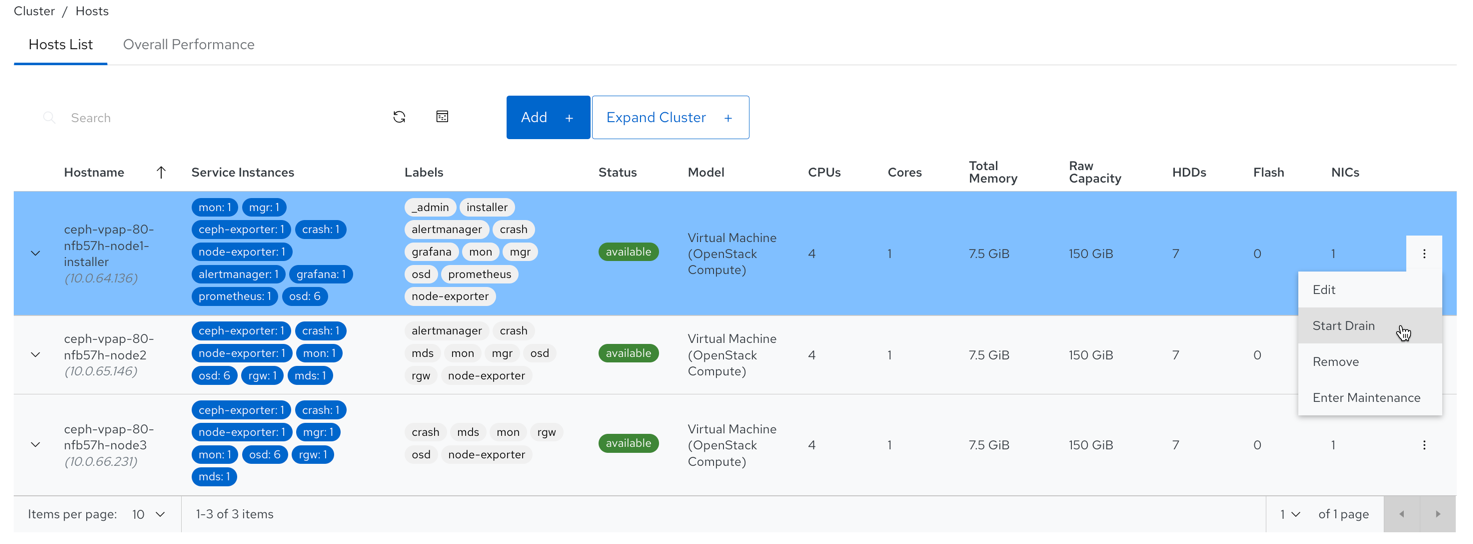

- 在仪表板导航中进入 Cluster→Hosts。

选择要删除的主机,然后从操作下拉菜单中选择 Start Drain。

图 9.1. 选择 Start Drain 选项

此选项排空主机中的所有守护进程。

注意_no_schedule标签自动应用到主机,这将阻止此主机上的守护进程部署。- 可选: 要停止主机中的守护进程排空,请从操作下拉列表中点 Stop Drain。

检查所有守护进程是否已从主机移除。

- 展开 host 行。

转至 Daemons 选项卡。

不应当列出守护进程。

重要在所有守护进程都已从集群中移除后,可以安全地从集群中删除主机。

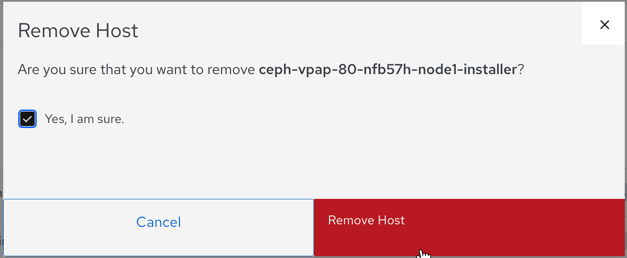

选择要删除的主机,然后单击操作下拉菜单中的 Remove。

在 Remove Host 通知中,选择 Yes, I am sure 并点 Remove Host。

通知显示主机已被成功删除。

第 10 章 在控制面板中管理 Ceph OSD

作为存储管理员,您可以在 Red Hat Ceph Storage 控制面板中监控和管理 OSD。

Red Hat Ceph Storage 仪表板的一些功能有:

- 列出 OSD、其状态、统计信息、属性、元数据、设备运行状况、性能计数器和性能详情。

- 将 OSD 关机标记为 down,即丢失、清除、重新加权、清理、深度清理、删除和选择 profile,以调整回填活动。

- 列出与 OSD 关联的所有驱动器。

- 设置并更改 OSD 的设备类。

- 在新的驱动器和主机上部署 OSD。

先决条件

- 正在运行的 Red Hat Ceph Storage 集群

-

在 Red Hat Ceph Storage 仪表板上的

cluster-manager访问级别

10.1. 在 Ceph 仪表板上管理 OSD

您可以在 Red Hat Ceph Storage Dashboard 上对 Ceph OSD 执行以下操作:

- 创建新 OSD。

- 编辑 OSD 的设备类。

- 将标记标记为 No Up,No Down,No In,或 No Out。

- 刮除和深度刮除 OSD。

- 重新加权 OSD。

- 将 OSD 标记为 Out, In, Down, 或 Lost。

- 清除 OSD。

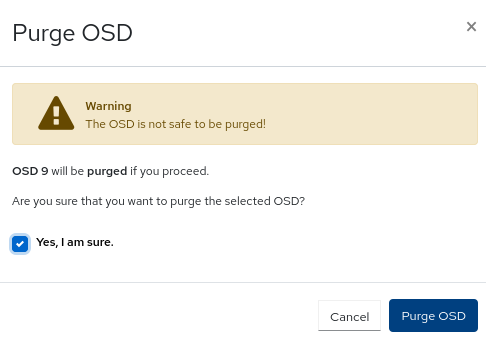

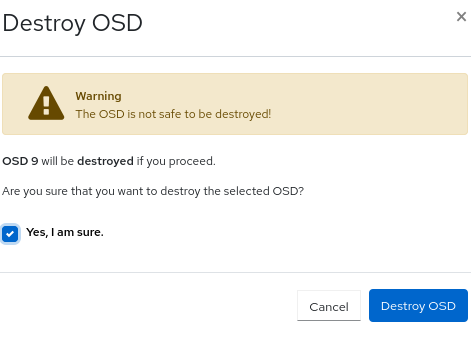

- 销毁 OSD。

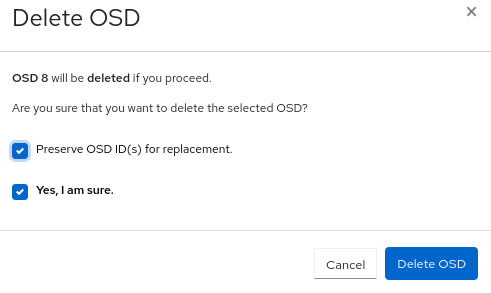

- 删除 OSD。

先决条件

- 一个正在运行的 Red Hat Ceph Storage 集群。

- 已安装仪表板。

- 主机、监控和管理器守护进程添加到存储集群中。

流程

在仪表板导航中进入 Cluster→OSDs。

创建 OSD

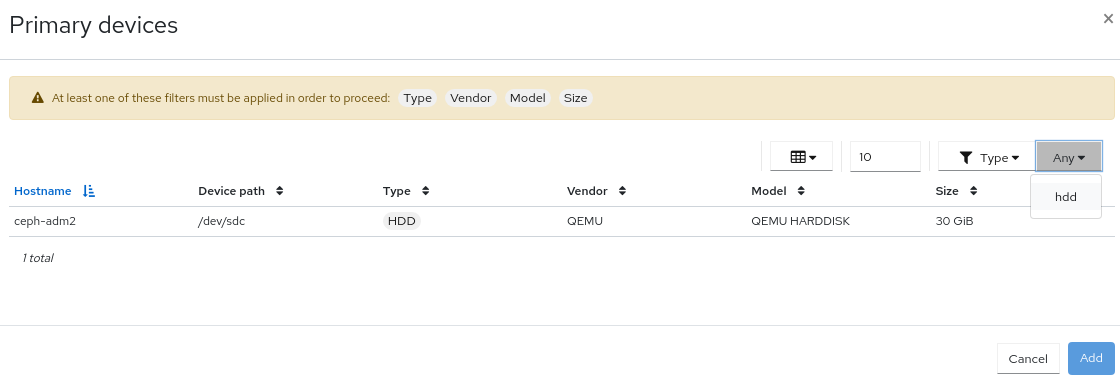

要创建 OSD,请从 OSD List 表中单击 Create。

图 10.1. 为 OSD 添加设备

注意确定您有可用的主机和几个可用的设备。检查 Cluster→Physical Disks 中可用的设备,并过滤 Available。

在 Create OSD 表单的 Deployment Options 部分中,选择以下选项之一:

- Cost/Capacity-optimized :集群使用所有可用的 HDD 部署。

- Throughput-optimized :最低设备用于存储数据,使用更快速的设备来存储日志/设备。

- IOPS-optmized :所有可用的 NVMe 设备都用于部署 OSD。

在 Advanced Mode 部分中,点 Add 添加主、WAL 和 DB 设备。

- 主设备 :主存储设备包含所有 OSD 数据。

- WAL 设备 : Write-Ahead-Log 设备用于 BlueStore 的内部日志,且仅在 WAL 设备比主设备快时使用。例如: NVMe 或 SSD 设备。

- DB 设备 :数据库设备用于存储 BlueStore 的内部元数据,且仅在 DB 设备比主设备更快时使用。例如: NVMe 或 SSD 设备。

- 要加密您的数据,出于安全目的,请从表单的 Features 部分中选择 Encryption。

- 单击 Preview。

在 OSD Creation Preview 对话框中,检查 OSD,再单击 Create。

通知显示 OSD 已成功创建,并且 OSD 状态从 in 和 down 变为 in 和 up。

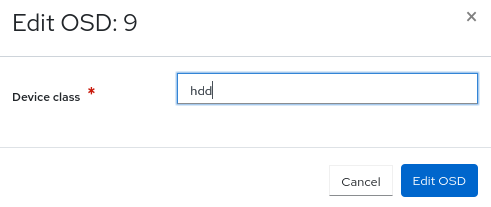

编辑 OSD

若要编辑 OSD,请选择行,再单击 Edit。

- 从 Edit OSD 表单,编辑设备类。

单击 Edit OSD。

图 10.2. 编辑 OSD

通知显示 OSD 已成功更新。

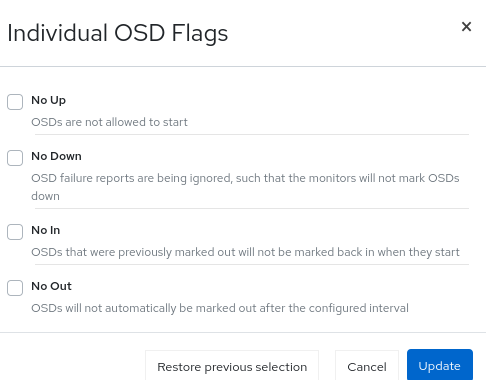

标记 OSD 标记

- 要标记 OSD 的标志,请选择行,然后从操作下拉列表中点 Flags。

- 在单个 OSD 标记 表单中,选择所需的 OSD 标志。

点 Update。

图 10.3. 标记 OSD 标记

通知显示 OSD 标志已被成功更新。

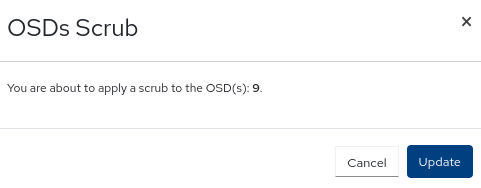

清理 OSD

- 要清理 OSD,请选择行,然后从操作下拉列表中单击 Scrub。

在 OSD Scrub 通知中,单击 Update。

图 10.4. 清理 OSD

通知显示 OSD 的清理成功启动。

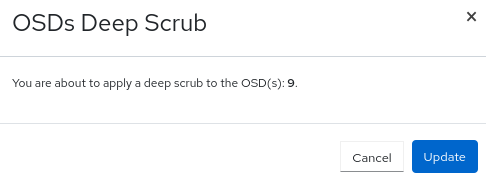

深度刮除 OSD

- 要深度清理 OSD,请选择行,然后从操作下拉列表中点 Deep Scrub。

在 OSD Deep Scrub 通知中,单击 Update。

图 10.5. 深度刮除 OSD

通知显示 OSD 的深度清理成功启动。

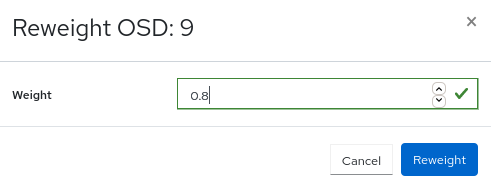

重新加权 OSD

- 要重新加权 OSD,请选择行,然后从操作下拉列表中点 Reweight。

- 在 Reweight OSD 表单中,输入 0 到 1 之间的值。

点 Reweight。

图 10.6. 重新加权 OSD

标记 OSD out

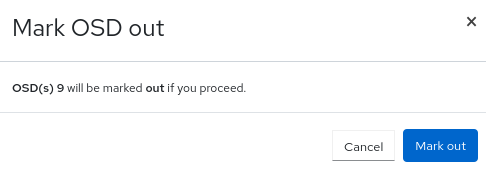

- 要将 OSD 标记为 out,请选择行,然后从操作下拉列表中单击 Mark Out。

在 Mark OSD out 通知中,单击 Mark Out。

图 10.7. 标记 OSD out

OSD 状态更改为 out。

将 OSD 标记为 in