管理文件系统

在 Red Hat Enterprise Linux 8 中创建、修改和管理文件系统

摘要

对红帽文档提供反馈

我们感谢您对我们文档的反馈。让我们了解如何改进它。

通过 Jira 提交反馈(需要帐户)

- 登录到 Jira 网站。

- 单击顶部导航栏中的 Create。

- 在 Summary 字段中输入描述性标题。

- 在 Description 字段中输入您对改进的建议。包括文档相关部分的链接。

- 点对话框底部的 Create。

第 1 章 可用文件系统概述

由于大量的可用选项以及所涉及的权衡,因此选择适合您应用程序的文件系统是一个重要的决定。

以下章节描述了 Red Hat Enterprise Linux 8 默认包括的文件系统,以及对最合适您应用程序的文件系统的建议。

1.1. 文件系统类型

Red Hat Enterprise Linux 8 支持各种文件系统(FS)。不同类型的文件系统可以解决不同类型的问题,它们的使用会根据特定应用程序而有所不同。在最一般的级别上,可用的文件系统可以分为以下主要类型:

| 类型 | 文件系统 | 属性和使用案例 |

|---|---|---|

| 磁盘或本地 FS | XFS | XFS 是 RHEL 中的默认文件系统。红帽建议将 XFS 部署为本地文件系统,除非有特定原因部署为其它:例如,兼容性或涉及性能方面的情况。 |

| ext4 | ext4 在 Linux 中有相似性的好处,其从较旧的 ext2 和 ext3 文件系统演变而来。在很多情况下,它在性能上可以与 XFS 相媲美。对 ext4 文件系统和文件大小的支持限制比 XFS 上的要低。 | |

| 网络或客户端-和-服务器 FS | NFS | 使用 NFS 在同一个网络中的多个系统间共享文件。 |

| SMB | 使用 SMB 进行与微软 Windows 系统的文件共享。 | |

| 共享存储或共享磁盘 FS | GFS2 | GFS2 为计算集群成员提供共享写入访问。其重点在于稳定性和可靠性,获得与本地文件系统类似的体验。SAS Grid、Tibco MQ、IBM Websphere MQ 和 Red Hat Active MQ 已被成功部署在 GFS2 上。 |

| 卷管理 FS | Stratis(技术预览) | Stratis 是基于 XFS 和 LVM 的组合构建的卷管理器。Stratis 的目的是模拟卷管理文件系统(如 Btrfs 和 ZFS)所提供的功能。可以手动构建此堆栈,但 Stratis 可减少配置的复杂度、实施最佳实践并整合错误信息。 |

1.2. 本地文件系统

本地文件系统是在单一本地服务器中运行并直接附加到存储中的文件系统。

例如,本地文件系统是内部 SATA 或 SAS 磁盘的唯一选择,可在当您的服务器具有带有本地驱动器的内部硬件 RAID 控制器时使用。当 SAN 上导出的设备未共享时,本地文件系统也是 SAN 连接的存储上最常用的文件系统。

所有本地文件系统都与 POSIX 兼容,且与所有支持的 Red Hat Enterprise Linux 版本完全兼容。与 POSIX 兼容的文件系统为一组定义良好的系统调用提供支持,如 read()、write() 和 seek()。

在考虑文件系统选择时,根据文件系统需要多大、它必须具有哪些唯一功能,以及如何在工作负载下执行文件系统。

- 可用的本地文件系统

- XFS

- ext4

1.3. XFS 文件系统

XFS 是一个高度可扩展、高性能、健壮且成熟的 64 位日志文件系统,其支持单个主机上非常大的文件和文件系统。它是 Red Hat Enterprise Linux 8 中的默认文件系统。XFS 最初于 1990 年代由 SGI 早期开发,并在非常大型的服务器和存储阵列中运行有很长的历史记录。

XFS 的功能包括:

- 可靠性

- 元数据日志,其确保系统崩溃后文件系统的完整性,方法是保留系统重启和重新挂载文件系统时可以重新执行的文件系统操作的记录,

- 广泛的运行时元数据一致性检查

- 可扩展且快速修复工具

- 配额日志。这可避免在崩溃后进行冗长的配额一致性检查。

- 可伸缩性和性能

- 支持最多 1024 TiB 的文件系统大小

- 支持大量并发操作的能力

- B-tree 索引,用于空闲空间的可扩展性管理

- 复杂的元数据读头算法

- 优化流视频工作负载

- 分配方案

- 基于扩展数据块的分配

- 条带化分配策略

- 延迟分配

- 空间预分配

- 动态分配的 inode

- 其他功能

- 基于 Reflink 的文件副本

- 严格集成备份和恢复工具

- 在线清理

- 在线文件系统增大

- 全面的诊断功能

-

扩展属性(

xattr)。这允许系统能够按文件关联多个额外的名称/值对。 - 项目或目录配额。这允许对目录树的配额限制。

- 小于秒的时间戳

性能特性

XFS 在具有企业工作负载的大型系统上具有高性能。大型系统是一个有相对较多的 CPU 、多个 HBA 和连接外部磁盘阵列的系统。XFS 在具有多线程、并行 I/O 工作负载的较小系统上也表现良好。

对于单线程、元数据密集型工作负载,XFS 的性能相对较低:例如,在单个线程中创建或删除大量小文件的工作负载。

1.4. ext4 文件系统

ext4 文件系统是 ext 文件系统系列的第四代。它是 Red Hat Enterprise Linux 6 中的默认文件系统。

ext4 驱动程序可以对 ext2 和 ext3 文件系统进行读写,但 ext4 文件系统格式与 ext2 和 ext3 驱动程序不兼容。

ext4 添加了几个新的改进的功能,例如:

- 支持的文件系统大小高达 50 TiB

- 基于扩展的元数据

- 延迟分配

- 日志的 checksum

- 大型存储支持

基于扩展数据块的元数据和延迟分配功能提供了一种更加紧凑和高效的方法来跟踪文件系统中的已用空间。这些功能提高了文件系统性能,并减少了元数据所占用的空间。延迟分配允许文件系统延迟选择新写入用户数据的永久位置,直到数据刷新到磁盘。这可实现更高的性能,因为它允许更大的、连续的分配,允许文件系统根据更佳的信息做出决策。

ext4 中使用 fsck 工具的文件系统修复时间比 在 ext2 和 ext3 中要快得多。一些文件系统修复的性能会增加最多 6 倍。

1.5. XFS 和 ext4 的比较

XFS 是 RHEL 中的默认文件系统。本节比较 XFS 和 ext4 的用法和功能。

- 元数据错误行为

-

在 ext4 中,当文件系统遇到元数据错误时您可以配置行为。默认的行为是继续操作。当 XFS 遇到不可恢复的元数据错误时,它会关闭文件系统,并返回

EFSCORRUPTED错误。 - 配额

在 ext4 中,您可以在创建文件系统时启用配额,或稍后在现有文件系统上启用配额。然后您可以使用挂载选项配置配额强制执行。

XFS 配额不是一个可重新挂载的选项。您必须在初始挂载中激活配额。

在 XFS 文件系统上运行

quotacheck命令没有效果。当您第一次打开配额记帐时,XFS 会自动检查配额。- 文件系统重新定义大小

- XFS 没有工具来缩小文件系统的大小。您只能增大 XFS 文件系统的大小。而 ext4 支持扩展和缩小文件系统大小。

- 内节点(inode)号

ext4 文件系统不支持超过 232 内节点。

XFS 支持动态内节点分配。XFS 文件系统上空间索引节点的大小计算为总文件系统空间的百分比。要防止系统耗尽 inode,管理员可以在文件系统创建后调整这个百分比,假设文件系统上剩余的可用空间。

某些应用程序无法正确处理 XFS 文件系统上大于232 的 inode 数。这些应用程序可能会导致 32 位 stat 调用失败,返回值为

EOVERFLOW。在以下情况下,inode 数超过 232:- 文件系统大于 1 TiB,其 inode 为 256 字节。

- 文件系统大于 2 TiB,其 inode 为 512 字节。

如果您的应用程序由于 inode 数太大而失败,请使用

-o inode32选项挂载 XFS 文件系统,来强制inode 数低于 232。请注意,使用inode32不会影响已分配了 64 位数的 inode。重要除非特定环境需要,否则 请勿 使用

inode32选项。inode32选项可改变分配行为。因此,如果没有可用空间在较低磁盘块中分配 inode ,则可能会出现ENOSPC错误。

1.6. 选择本地文件系统

要选择一个满足应用程序要求的文件系统,您必须了解要在其上部署文件系统的目标系统。一般情况下,请使用 XFS,除非您有 ext4 的特定用例。

- XFS

- 对于大规模部署,请使用 XFS,特别是在处理大型文件(几百兆字节)和高 I/O 并发时。XFS 在具有高带宽(超过 200MB/s)和 1000 IOPS 的环境中执行最佳执行。但是,与 ext4 相比,它会消耗更多 CPU 资源用于元数据操作,且不支持文件系统缩小。

- ext4

- 对于 I/O 带宽有限的较小的系统或环境,ext4 可能更加适合。它在单线程、较低 I/O 工作负载和具有较低吞吐量要求的环境中表现更好。ext4 也支持离线缩减,这在调整文件系统大小时需要时很有用。

在目标服务器和存储系统上基准测试您的应用程序的性能,以确保所选的文件系统满足您的性能和可扩展性要求。

| 场景 | 推荐的文件系统 |

|---|---|

| 没有特殊用例 | XFS |

| 大服务器 | XFS |

| 大存储设备 | XFS |

| 大文件 | XFS |

| 多线程 I/O | XFS |

| 单线程 I/O | ext4 |

| 有限 I/O 功能(在 1000 IOPS 下) | ext4 |

| 有限带宽(在 200MB/s 下) | ext4 |

| CPU 绑定工作负载 | ext4 |

| 支持离线缩小 | ext4 |

1.7. 网络文件系统

网络文件系统也称为客户端/服务器文件系统,使客户端系统能够访问存储在共享服务器上的文件。这使得多个系统上的多个用户可以共享文件和存储资源。

此类文件系统构建自一个或多个服务器,它们将一组文件系统导出到一个或多个客户端。客户端节点无法访问底层的块存储,而是使用允许更好的访问控制的协议来与存储进行交互。

- 可用网络文件系统

- RHEL 客户最常用的客户端/服务器文件系统是 NFS 文件系统。RHEL 提供了一个 NFS 服务器组件,来通过网络导出本地文件系统,并提供 NFS 客户端来导入这些文件系统。

- RHEL 还包括 CIFS 客户端,其支持流行的 Microsoft SMB 文件服务器来实现 Windows 互操作性。用户空间 Samba 服务器为 Windows 客户端提供 RHEL 服务器的 Microsoft SMB 服务。

1.10. 卷管理文件系统

卷管理文件系统集成整个存储堆栈,以实现简洁和堆栈内优化。

- 可用卷管理文件系统

- Red Hat Enterprise Linux 8 作为技术预览提供 Stratis 卷管理器。Stratis 对文件系统层使用 XFS,并将其与 LVM、设备映射器和其他组件集成。

Stratis 首次在 Red Hat Enterprise Linux 8.0 中发布。它被设计为填补红帽弃用 Btrfs 时出现的空白。Stratis 1.0 是一个直观的、基于命令行的卷管理器,可以在隐藏用户复杂性的同时执行重要的存储管理操作:

- 卷管理

- 创建池

- 精简存储池

- 快照

- 自动读取缓存

Stratis 提供强大的功能,但目前缺乏其他产品(如 Btrfs 或 ZFS)的某些功能。最值得注意的是,它不支持带自我修复的 CRC。

第 2 章 使用 RHEL 系统角色管理本地存储

要使用 Ansible 管理 LVM 和本地文件系统(FS),您可以使用 存储 角色,这是 RHEL 8 中可用的 RHEL 系统角色之一。

使用 存储 角色可让您自动管理多台机器上的磁盘和逻辑卷上的文件系统,以及从 RHEL 7.7 开始的所有 RHEL 版本。

有关 RHEL 系统角色以及如何应用它们的更多信息,请参阅 RHEL 系统角色简介。

2.1. 使用 storage RHEL 系统角色在块设备上创建 XFS 文件系统

示例 Ansible playbook 使用 storage 角色,使用默认参数在块设备上创建一个 XFS 文件系统。如果 /dev/sdb 设备上的文件系统或者挂载点目录不存在,playbook 会创建它们。

存储 角色只能在未分区、整个磁盘或逻辑卷(LV)上创建文件系统。它不能在分区中创建文件系统。

先决条件

- 您已准备好控制节点和受管节点

- 以可在受管主机上运行 playbook 的用户登录到控制节点。

-

您用于连接到受管节点的帐户对它们具有

sudo权限。

流程

创建一个包含以下内容的 playbook 文件,如

~/playbook.yml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例 playbook 中指定的设置包括以下内容:

name: barefs-

卷名称(示例中为

barefs)目前是任意的。storage角色根据disks属性下列出的磁盘设备来识别卷。 fs_type: < ;file_system>-

如果要使用默认的文件系统 XFS,您可以省略

fs_type参数。 disks: <list_of_disks_and_volumes>磁盘和 LV 名称的 YAML 列表。要在 LV 上创建文件系统,请在

disks属性下提供 LVM 设置,包括括起来的卷组。详情请参阅 使用 storage RHEL 系统角色创建或者调整逻辑卷大小 。不要提供到 LV 设备的路径。

有关 playbook 中使用的所有变量的详情,请查看控制节点上的

/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。验证 playbook 语法:

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 请注意,这个命令只验证语法,不能防止错误的、但有效的配置。

运行 playbook:

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2. 使用 storage RHEL 系统角色永久挂载文件系统

示例 Ansible playbook 使用 storage 角色来永久挂载现有的文件系统。它通过向 /etc/fstab 文件中添加合适的条目来确保文件系统立即可用并永久挂载。这允许文件系统在重启后保持挂载。如果 /dev/sdb 设备上的文件系统或者挂载点目录不存在,playbook 会创建它们。

先决条件

- 您已准备好控制节点和受管节点

- 以可在受管主机上运行 playbook 的用户登录到控制节点。

-

您用于连接到受管节点的帐户对它们具有

sudo权限。

流程

创建一个包含以下内容的 playbook 文件,如

~/playbook.yml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 有关 playbook 中使用的所有变量的详情,请查看控制节点上的

/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。验证 playbook 语法:

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 请注意,这个命令只验证语法,不能防止错误的、但有效的配置。

运行 playbook:

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. 使用 storage RHEL 系统角色创建或者调整逻辑卷大小

使用 storage 角色执行以下任务:

- 在由多个磁盘组成的卷组中创建 LVM 逻辑卷

- 调整 LVM 上现有文件系统的大小

- 以池总大小的百分比表示 LVM 卷大小

如果卷组不存在,角色会创建它。如果逻辑卷在卷组中存在,如果大小与 playbook 中指定的内容不匹配,则会调整大小。

如果您要缩小逻辑卷,为了避免数据丢失,您必须确保该逻辑卷上的文件系统没有使用正在缩小的逻辑卷中的空间。

先决条件

- 您已准备好控制节点和受管节点

- 以可在受管主机上运行 playbook 的用户登录到控制节点。

-

您用于连接到受管节点的帐户对它们具有

sudo权限。

流程

创建一个包含以下内容的 playbook 文件,如

~/playbook.yml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例 playbook 中指定的设置包括如下:

size: <size>- 您必须使用单位(如 GiB)或百分比(例如 60%)来指定大小。

有关 playbook 中使用的所有变量的详情,请查看控制节点上的

/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。验证 playbook 语法:

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 请注意,这个命令只验证语法,不能防止错误的、但有效的配置。

运行 playbook:

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

验证指定的卷是否已创建或调整到请求的大小:

ansible managed-node-01.example.com -m command -a 'lvs myvg'

# ansible managed-node-01.example.com -m command -a 'lvs myvg'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4. 使用 storage RHEL 系统角色启用在线块丢弃

您可以使用在线块丢弃选项挂载 XFS 文件系统,来自动丢弃未使用的块。

先决条件

- 您已准备好控制节点和受管节点

- 以可在受管主机上运行 playbook 的用户登录到控制节点。

-

您用于连接到受管节点的帐户对它们具有

sudo权限。

流程

创建一个包含以下内容的 playbook 文件,如

~/playbook.yml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 有关 playbook 中使用的所有变量的详情,请查看控制节点上的

/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。验证 playbook 语法:

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 请注意,这个命令只验证语法,不能防止错误的、但有效的配置。

运行 playbook:

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

验证在线块丢弃选项是否已启用:

ansible managed-node-01.example.com -m command -a 'findmnt /mnt/data'

# ansible managed-node-01.example.com -m command -a 'findmnt /mnt/data'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5. 使用 storage RHEL 系统角色创建并挂载文件系统

示例 Ansible playbook 使用 storage 角色创建和挂载文件系统。它通过向 /etc/fstab 文件中添加合适的条目来确保文件系统立即可用并永久挂载。这允许文件系统在重启后保持挂载。如果 /dev/sdb 设备上的文件系统或者挂载点目录不存在,playbook 会创建它们。

先决条件

- 您已准备好控制节点和受管节点

- 以可在受管主机上运行 playbook 的用户登录到控制节点。

-

您用于连接到受管节点的帐户对它们具有

sudo权限。

流程

创建一个包含以下内容的 playbook 文件,如

~/playbook.yml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例 playbook 中指定的设置包括以下内容:

disks: <list_of_devices>- 角色在创建卷时使用的设备名称的 YAML 列表。

fs_type: < ;file_system>-

指定角色应在卷上设置的文件系统。您可以选择

xfs、ext3、ext4、swap或unformatted。 label-name: < ;file_system_label>- 可选:设置文件系统的标签。

mount_point: < directory>-

可选:如果卷应自动挂载,请将

mount_point变量设置为应挂载卷的目录。

有关 playbook 中使用的所有变量的详情,请查看控制节点上的

/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。验证 playbook 语法:

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 请注意,这个命令只验证语法,不能防止错误的、但有效的配置。

运行 playbook:

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6. 使用 storage RHEL 系统角色配置 RAID 卷

使用 storage 系统角色,您可以使用 Red Hat Ansible Automation Platform 和 Ansible-Core 在 RHEL 上配置一个 RAID 卷。使用参数创建一个 Ansible playbook,以配置 RAID 卷以满足您的要求。

设备名称在某些情况下可能会改变,例如:当您在系统中添加新磁盘时。因此,为了避免数据丢失,请在 playbook 中使用持久性命名属性。有关持久性命名属性的更多信息,请参阅 持久性命名属性概述。

先决条件

- 您已准备好控制节点和受管节点

- 以可在受管主机上运行 playbook 的用户登录到控制节点。

-

您用于连接到受管节点的帐户对它们具有

sudo权限。

流程

创建一个包含以下内容的 playbook 文件,如

~/playbook.yml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 有关 playbook 中使用的所有变量的详情,请查看控制节点上的

/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。验证 playbook 语法:

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 请注意,这个命令只验证语法,不能防止错误的、但有效的配置。

运行 playbook:

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

验证阵列是否被正确创建:

ansible managed-node-01.example.com -m command -a 'mdadm --detail /dev/md/data'

# ansible managed-node-01.example.com -m command -a 'mdadm --detail /dev/md/data'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7. 使用 storage RHEL 系统角色配置一个带有 RAID 的 LVM 池

使用 storage 系统角色,您可以使用 Red Hat Ansible Automation Platform 在 RHEL 上配置一个带有 RAID 的 LVM 池。您可以使用可用参数建立一个 Ansible playbook,来配置带有 RAID 的 LVM 池。

先决条件

- 您已准备好控制节点和受管节点

- 以可在受管主机上运行 playbook 的用户登录到控制节点。

-

您用于连接到受管节点的帐户对它们具有

sudo权限。

流程

创建一个包含以下内容的 playbook 文件,如

~/playbook.yml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 有关 playbook 中使用的所有变量的详情,请查看控制节点上的

/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。验证 playbook 语法:

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 请注意,这个命令只验证语法,不能防止错误的、但有效的配置。

运行 playbook:

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

验证您的池是否在 RAID 上:

ansible managed-node-01.example.com -m command -a 'lsblk'

# ansible managed-node-01.example.com -m command -a 'lsblk'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.8. 使用 storage RHEL 系统角色为 RAID LVM 卷配置条带大小

使用 storage 系统角色,您可以使用 Red Hat Ansible Automation Platform 在 RHEL 上为 RAID LVM 卷配置条带大小。您可以使用可用参数建立一个 Ansible playbook,来配置带有 RAID 的 LVM 池。

先决条件

- 您已准备好控制节点和受管节点

- 以可在受管主机上运行 playbook 的用户登录到控制节点。

-

您用于连接到受管节点的帐户对它们具有

sudo权限。

流程

创建一个包含以下内容的 playbook 文件,如

~/playbook.yml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 有关 playbook 中使用的所有变量的详情,请查看控制节点上的

/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。验证 playbook 语法:

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 请注意,这个命令只验证语法,不能防止错误的、但有效的配置。

运行 playbook:

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

验证条带大小是否被设置为所需的大小:

ansible managed-node-01.example.com -m command -a 'lvs -o+stripesize /dev/my_pool/my_volume'

# ansible managed-node-01.example.com -m command -a 'lvs -o+stripesize /dev/my_pool/my_volume'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.9. 使用 storage RHEL 系统角色配置 LVM-VDO 卷

您可以使用 storage RHEL 系统角色在 LVM (LVM-VDO)上创建一个启用了压缩和去重的 VDO 卷。

由于 storage 系统角色使用 LVM-VDO,因此每个池只能创建一个卷。

先决条件

- 您已准备好控制节点和受管节点

- 以可在受管主机上运行 playbook 的用户登录到控制节点。

-

您用于连接到受管节点的帐户对它们具有

sudo权限。

流程

创建一个包含以下内容的 playbook 文件,如

~/playbook.yml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例 playbook 中指定的设置包括如下:

vdo_pool_size: <size>- 卷在设备上的实际大小。您可以以人类可读的格式指定大小,如 10 GiB。如果没有指定单位,默认为字节。

size: <size>- VDO 卷的虚拟大小。

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

ansible managed-node-01.example.com -m command -a 'lvs -o+vdo_compression,vdo_compression_state,vdo_deduplication,vdo_index_state' LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert VDOCompression VDOCompressionState VDODeduplication VDOIndexState mylv1 myvg vwi-a-v--- 3.00t vpool0 enabled online enabled online

$ ansible managed-node-01.example.com -m command -a 'lvs -o+vdo_compression,vdo_compression_state,vdo_deduplication,vdo_index_state' LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert VDOCompression VDOCompressionState VDODeduplication VDOIndexState mylv1 myvg vwi-a-v--- 3.00t vpool0 enabled online enabled onlineCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.10.

ansible-vault create ~/vault.yml New Vault password: <vault_password> Confirm New Vault password: <vault_password>

$ ansible-vault create ~/vault.yml New Vault password: <vault_password> Confirm New Vault password: <vault_password>Copy to Clipboard Copied! Toggle word wrap Toggle overflow luks_password: <password>

luks_password: <password>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ansible-playbook --ask-vault-pass --syntax-check ~/playbook.yml

$ ansible-playbook --ask-vault-pass --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ansible-playbook --ask-vault-pass ~/playbook.yml

$ ansible-playbook --ask-vault-pass ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

ansible managed-node-01.example.com -m command -a 'cryptsetup luksUUID /dev/sdb' 4e4e7970-1822-470e-b55a-e91efe5d0f5c

# ansible managed-node-01.example.com -m command -a 'cryptsetup luksUUID /dev/sdb' 4e4e7970-1822-470e-b55a-e91efe5d0f5cCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 3 章

3.1.

3.2.

3.3.

第 6 章

6.1.

6.2.

6.3.

6.3.1.

/dev/disk/by-uuid/3e6be9de-8139-11d1-9106-a43f08d823a6

/dev/disk/by-uuid/3e6be9de-8139-11d1-9106-a43f08d823a6

UUID=3e6be9de-8139-11d1-9106-a43f08d823a6

UUID=3e6be9de-8139-11d1-9106-a43f08d823a6

/dev/disk/by-label/Boot

/dev/disk/by-label/Boot

LABEL=Boot

LABEL=Boot

6.3.2.

例 6.1.

|

|

|

|

|

|

|

|

|

|

|

|

例 6.2.

|

|

|

|

|

|

|

|

|

6.4.

例 6.3.

6.5.

6.6.

lsblk --fs storage-device

$ lsblk --fs storage-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例 6.4.

lsblk --fs /dev/sda1 NAME FSTYPE LABEL UUID MOUNTPOINT sda1 xfs Boot afa5d5e3-9050-48c3-acc1-bb30095f3dc4 /boot

$ lsblk --fs /dev/sda1 NAME FSTYPE LABEL UUID MOUNTPOINT sda1 xfs Boot afa5d5e3-9050-48c3-acc1-bb30095f3dc4 /bootCopy to Clipboard Copied! Toggle word wrap Toggle overflow lsblk --output +PARTUUID

$ lsblk --output +PARTUUIDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例 6.5.

lsblk --output +PARTUUID /dev/sda1 NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT PARTUUID sda1 8:1 0 512M 0 part /boot 4cd1448a-01

$ lsblk --output +PARTUUID /dev/sda1 NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT PARTUUID sda1 8:1 0 512M 0 part /boot 4cd1448a-01Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例 6.6.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.7.

xfs_admin -U new-uuid -L new-label storage-device udevadm settle

# xfs_admin -U new-uuid -L new-label storage-device # udevadm settleCopy to Clipboard Copied! Toggle word wrap Toggle overflow tune2fs -U new-uuid -L new-label storage-device udevadm settle

# tune2fs -U new-uuid -L new-label storage-device # udevadm settleCopy to Clipboard Copied! Toggle word wrap Toggle overflow swaplabel --uuid new-uuid --label new-label swap-device udevadm settle

# swaplabel --uuid new-uuid --label new-label swap-device # udevadm settleCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 7 章

7.1.

parted /dev/sda

# parted /dev/sdaCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) select block-device

(parted) select block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.

parted block-device

# parted block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) print

(parted) printCopy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) mklabel table-type

(parted) mklabel table-typeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例 7.1.

(parted) mklabel gpt

(parted) mklabel gptCopy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) print

(parted) printCopy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) quit

(parted) quitCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3.

parted block-device

# parted block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) print

(parted) printCopy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) mkpart part-type name fs-type start end

(parted) mkpart part-type name fs-type start endCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例 7.2.

(parted) mkpart primary 1024MiB 2048MiB

(parted) mkpart primary 1024MiB 2048MiBCopy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) print

(parted) printCopy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) quit

(parted) quitCopy to Clipboard Copied! Toggle word wrap Toggle overflow udevadm settle

# udevadm settleCopy to Clipboard Copied! Toggle word wrap Toggle overflow cat /proc/partitions

# cat /proc/partitionsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4.

parted block-device

# parted block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) print

(parted) printCopy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) rm minor-number

(parted) rm minor-numberCopy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) print

(parted) printCopy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) quit

(parted) quitCopy to Clipboard Copied! Toggle word wrap Toggle overflow cat /proc/partitions

# cat /proc/partitionsCopy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl daemon-reload

# systemctl daemon-reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow grubby --info=ALL

# grubby --info=ALLCopy to Clipboard Copied! Toggle word wrap Toggle overflow grubby --update-kernel=ALL --remove-args="option"

# grubby --update-kernel=ALL --remove-args="option"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

dracut --force --verbose

# dracut --force --verboseCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.5.

parted block-device

# parted block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) print

(parted) printCopy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) resizepart 1 2GiB

(parted) resizepart 1 2GiBCopy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) print

(parted) printCopy to Clipboard Copied! Toggle word wrap Toggle overflow (parted) quit

(parted) quitCopy to Clipboard Copied! Toggle word wrap Toggle overflow cat /proc/partitions

# cat /proc/partitionsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 8 章

8.1.

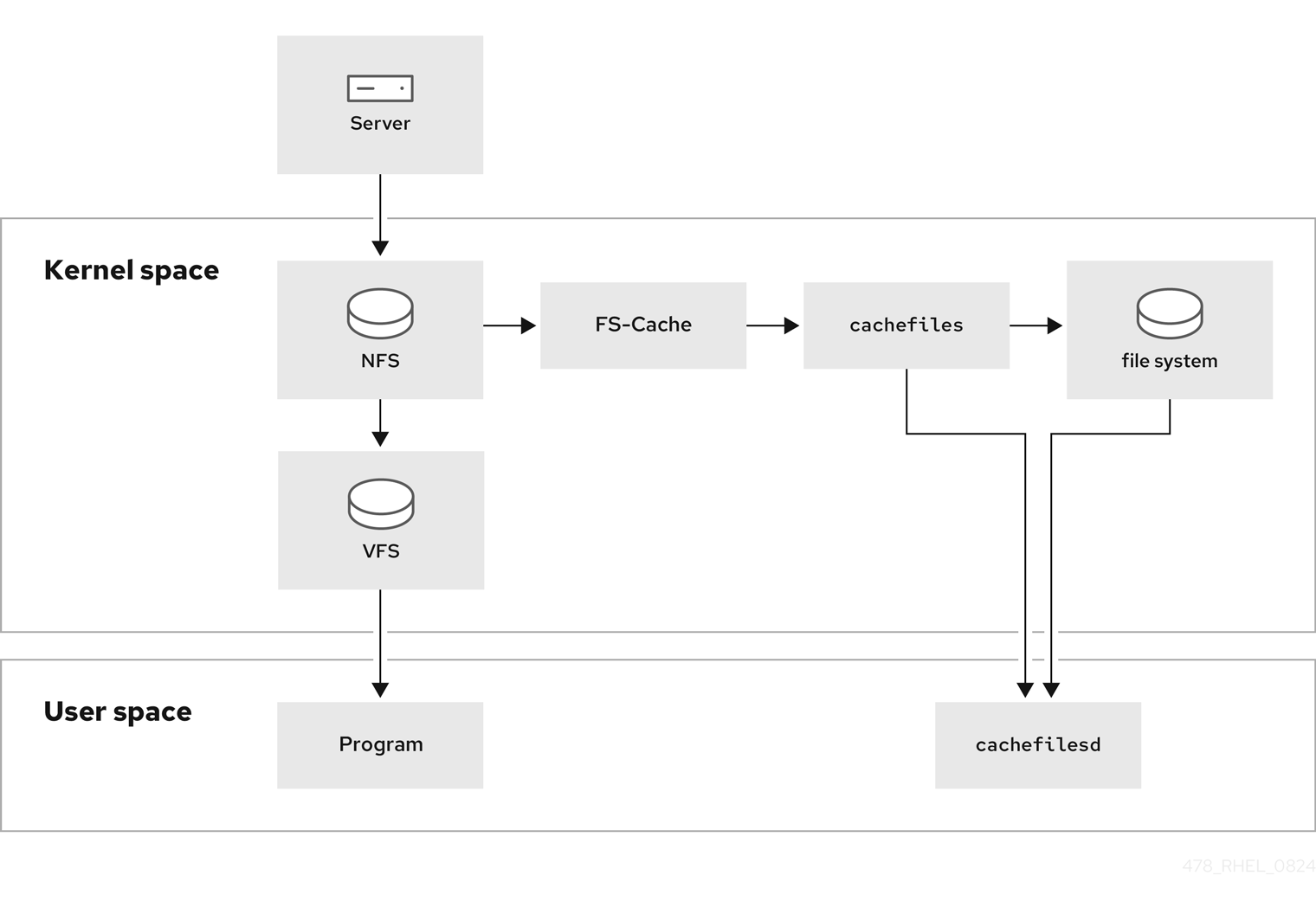

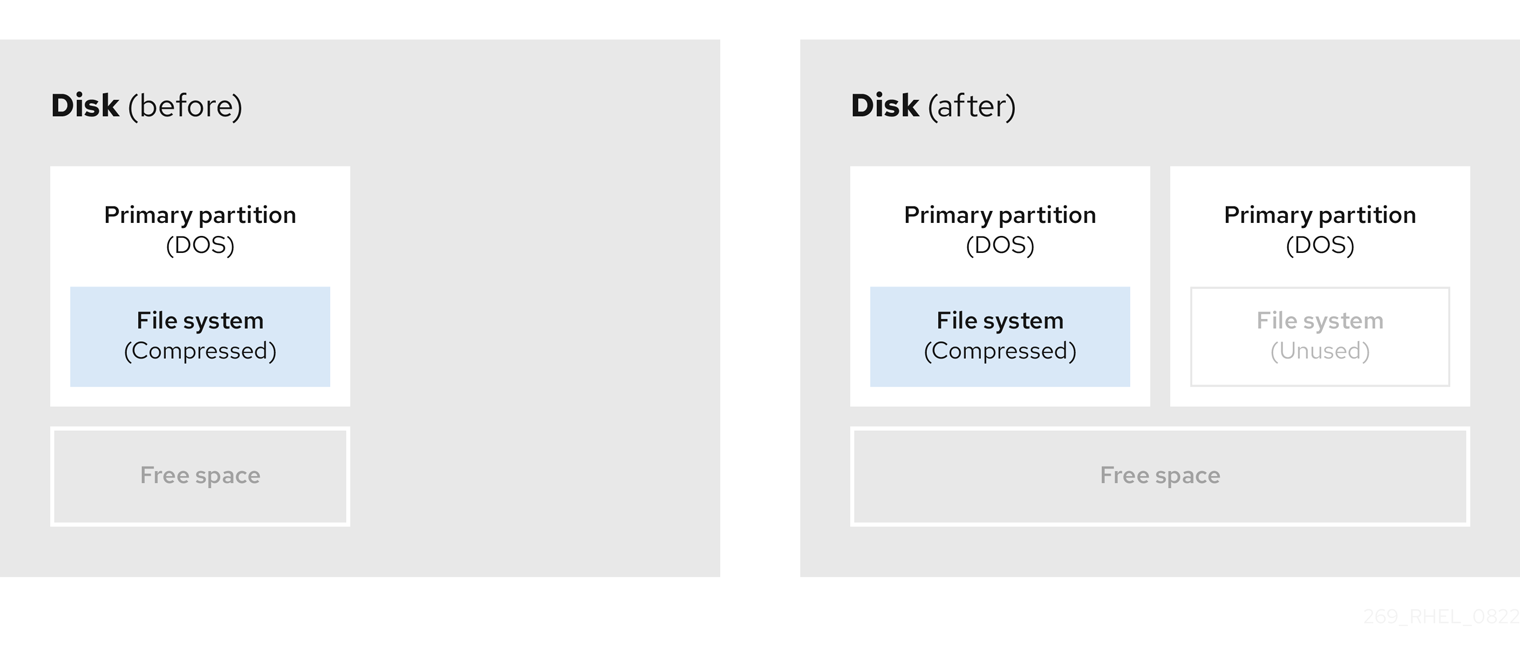

图 8.1.

[D]

8.2.

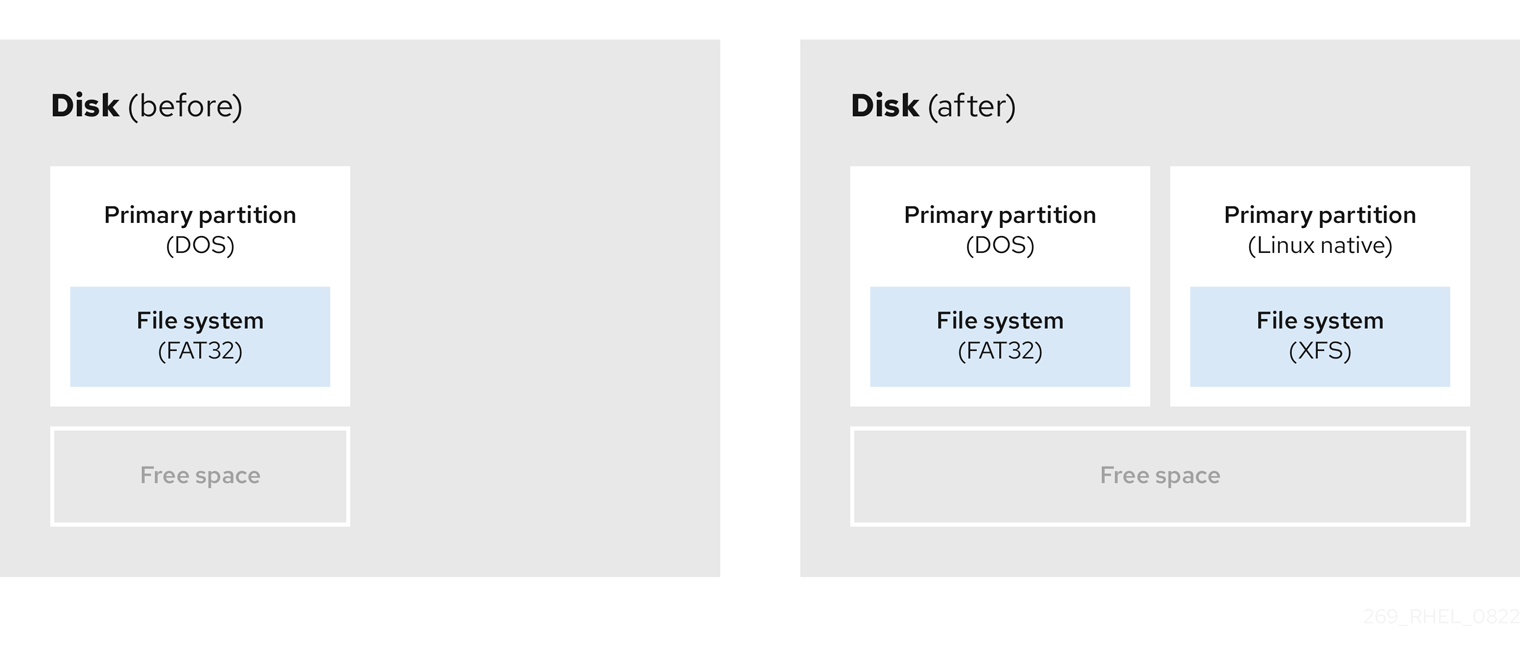

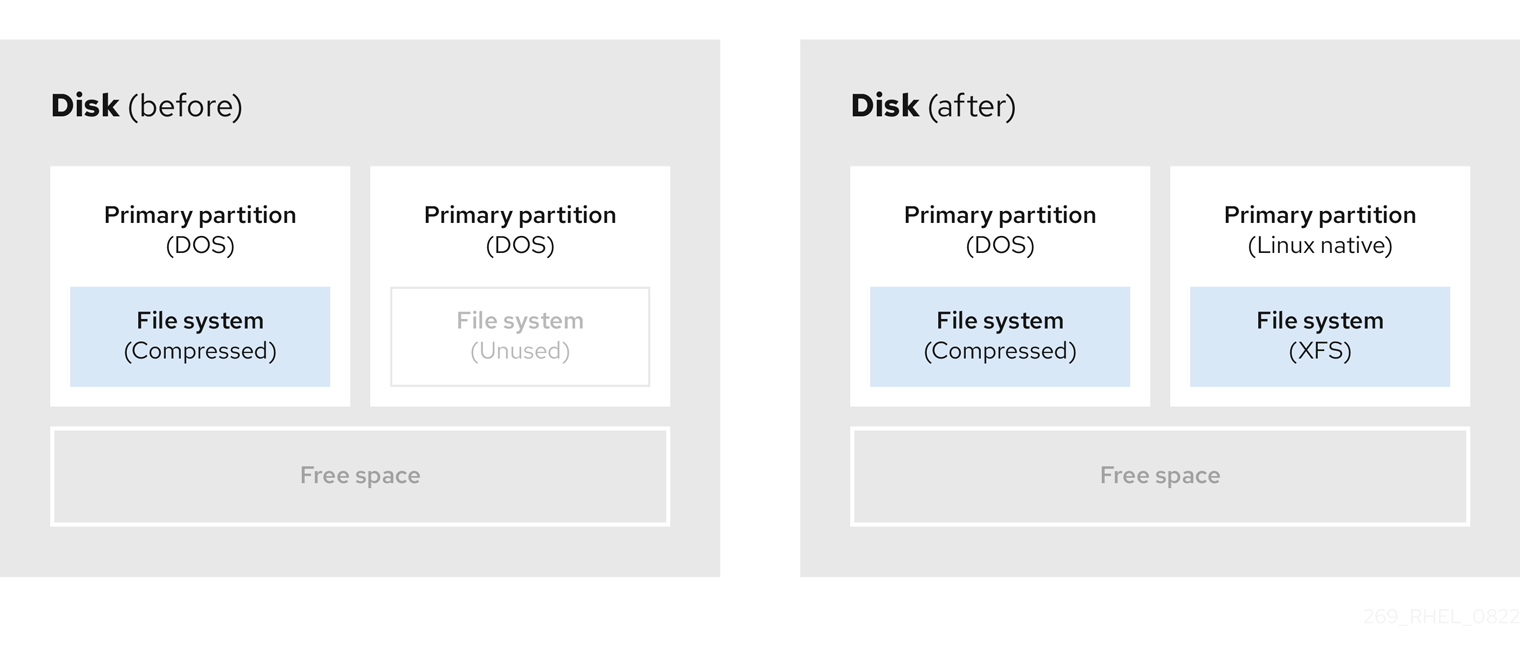

图 8.2.

[D]

8.3.

8.3.1.

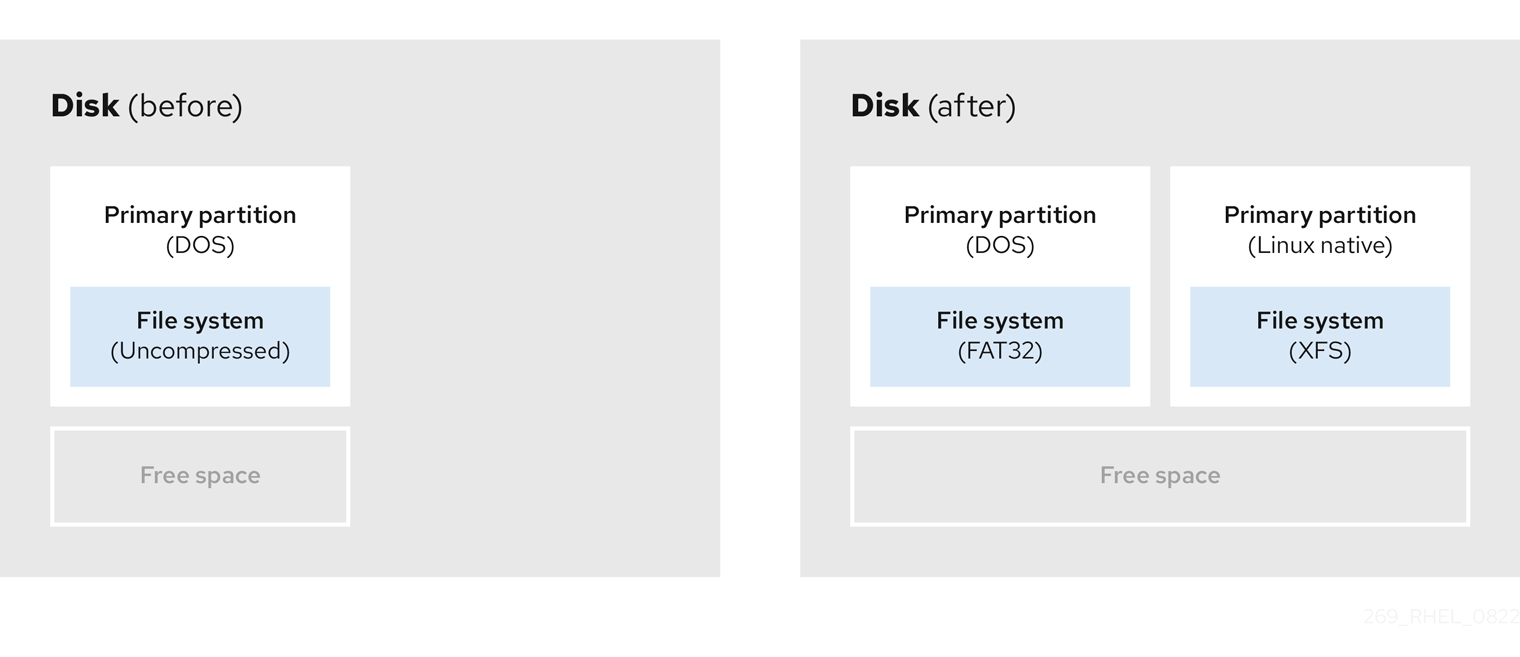

图 8.3.

[D]

8.3.2.

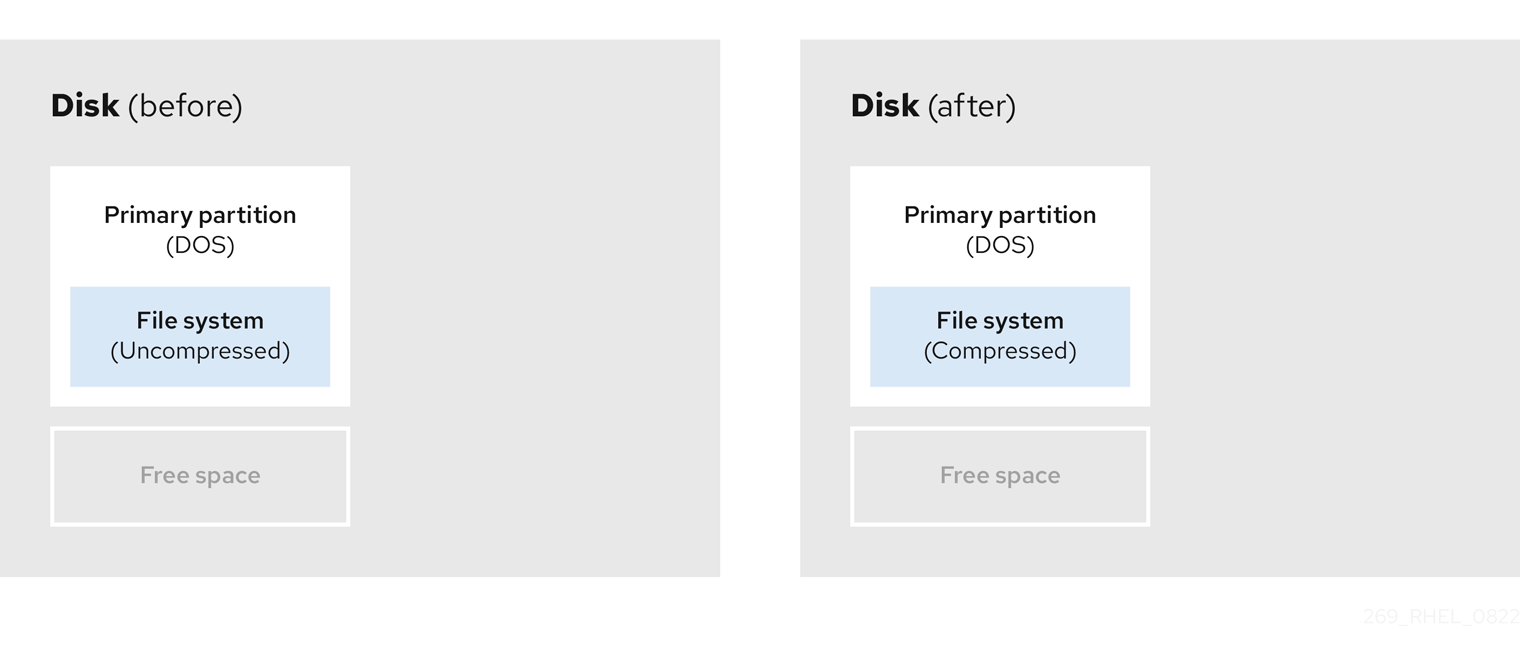

图 8.4.

[D]

图 8.5.

[D]

图 8.6.

[D]

第 9 章

9.1.

9.2.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

第 10 章

10.1.

mkfs.xfs block-device

# mkfs.xfs block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow mkfs.xfs block-device

# mkfs.xfs block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow mkfs.xfs -d su=64k,sw=4 /dev/sda3

# mkfs.xfs -d su=64k,sw=4 /dev/sda3Copy to Clipboard Copied! Toggle word wrap Toggle overflow

udevadm settle

# udevadm settleCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 11 章

11.1.

11.2.

xfsdump -l level [-L label] \ -f backup-destination path-to-xfs-filesystem

# xfsdump -l level [-L label] \ -f backup-destination path-to-xfs-filesystemCopy to Clipboard Copied! Toggle word wrap Toggle overflow

例 11.1.

xfsdump -l 0 -f /backup-files/boot.xfsdump /boot xfsdump -l 0 -f /backup-files/data.xfsdump /data

# xfsdump -l 0 -f /backup-files/boot.xfsdump /boot # xfsdump -l 0 -f /backup-files/data.xfsdump /dataCopy to Clipboard Copied! Toggle word wrap Toggle overflow xfsdump -l 0 -L "backup_boot" -f /dev/st0 /boot xfsdump -l 0 -L "backup_data" -f /dev/st0 /data

# xfsdump -l 0 -L "backup_boot" -f /dev/st0 /boot # xfsdump -l 0 -L "backup_data" -f /dev/st0 /dataCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 12 章

12.1.

12.2.

xfsrestore [-r] [-S session-id] [-L session-label] [-i] -f backup-location restoration-path

# xfsrestore [-r] [-S session-id] [-L session-label] [-i] -f backup-location restoration-pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow

例 12.1.

xfsrestore -f /backup-files/boot.xfsdump /mnt/boot/ xfsrestore -f /backup-files/data.xfsdump /mnt/data/

# xfsrestore -f /backup-files/boot.xfsdump /mnt/boot/ # xfsrestore -f /backup-files/data.xfsdump /mnt/data/Copy to Clipboard Copied! Toggle word wrap Toggle overflow xfsrestore -L "backup_boot" -f /dev/st0 /mnt/boot/ xfsrestore -S "45e9af35-efd2-4244-87bc-4762e476cbab" \ -f /dev/st0 /mnt/data/

# xfsrestore -L "backup_boot" -f /dev/st0 /mnt/boot/ # xfsrestore -S "45e9af35-efd2-4244-87bc-4762e476cbab" \ -f /dev/st0 /mnt/data/Copy to Clipboard Copied! Toggle word wrap Toggle overflow

12.3.

第 13 章

13.1.

xfs_growfs file-system -D new-size

# xfs_growfs file-system -D new-sizeCopy to Clipboard Copied! Toggle word wrap Toggle overflow xfs_info block-device ... data = bsize=4096 ...

# xfs_info block-device ... data = bsize=4096 ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 14 章

14.1.

14.2.

14.3.

echo value > /sys/fs/xfs/device/error/metadata/condition/max_retries

# echo value > /sys/fs/xfs/device/error/metadata/condition/max_retriesCopy to Clipboard Copied! Toggle word wrap Toggle overflow echo value > /sys/fs/xfs/device/error/metadata/condition/retry_timeout_second

# echo value > /sys/fs/xfs/device/error/metadata/condition/retry_timeout_secondCopy to Clipboard Copied! Toggle word wrap Toggle overflow

14.4.

echo value > /sys/fs/xfs/device/error/metadata/default/max_retries

# echo value > /sys/fs/xfs/device/error/metadata/default/max_retriesCopy to Clipboard Copied! Toggle word wrap Toggle overflow echo value > /sys/fs/xfs/device/error/metadata/default/retry_timeout_seconds

# echo value > /sys/fs/xfs/device/error/metadata/default/retry_timeout_secondsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

14.5.

echo 1 > /sys/fs/xfs/device/error/fail_at_unmount

# echo 1 > /sys/fs/xfs/device/error/fail_at_unmountCopy to Clipboard Copied! Toggle word wrap Toggle overflow echo 0 > /sys/fs/xfs/device/error/fail_at_unmount

# echo 0 > /sys/fs/xfs/device/error/fail_at_unmountCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 15 章

15.1.

15.2.

15.3.

例 15.1.

mount: /mount-point: mount(2) system call failed: Structure needs cleaning.

mount: /mount-point: mount(2) system call failed: Structure needs cleaning.

15.4.

mount file-system umount file-system

# mount file-system # umount file-systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意xfs_repair -n block-device

# xfs_repair -n block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount file-system

# mount file-systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow

15.5.

xfs_metadump block-device metadump-file

# xfs_metadump block-device metadump-fileCopy to Clipboard Copied! Toggle word wrap Toggle overflow

mount file-system umount file-system

# mount file-system # umount file-systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow xfs_repair block-device

# xfs_repair block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 警告

xfs_repair -L block-device

# xfs_repair -L block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

mount file-system

# mount file-systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow

15.6.

15.7.

mount file-system umount file-system

# mount file-system # umount file-systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow e2fsck -n block-device

# e2fsck -n block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意

15.8.

- 注意

e2image -r block-device image-file

# e2image -r block-device image-fileCopy to Clipboard Copied! Toggle word wrap Toggle overflow e2image -Q block-device image-file

# e2image -Q block-device image-fileCopy to Clipboard Copied! Toggle word wrap Toggle overflow

mount file-system umount file-system

# mount file-system # umount file-systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow e2fsck -p block-device

# e2fsck -p block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 16 章

16.1.

mount directory

# mount directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount device

# mount deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

16.2.

findmnt

$ findmntCopy to Clipboard Copied! Toggle word wrap Toggle overflow findmnt --types fs-type

$ findmnt --types fs-typeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例 16.1.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

16.3.

findmnt mount-point

$ findmnt mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow

mount device mount-point

# mount device mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例 16.2.

mount UUID=ea74bbec-536d-490c-b8d9-5b40bbd7545b /mnt/data

# mount UUID=ea74bbec-536d-490c-b8d9-5b40bbd7545b /mnt/dataCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount --types type device mount-point

# mount --types type device mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例 16.3.

mount --types nfs4 host:/remote-export /mnt/nfs

# mount --types nfs4 host:/remote-export /mnt/nfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

16.4.

mount --move old-directory new-directory

# mount --move old-directory new-directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例 16.4.

mount --move /mnt/userdirs /home

# mount --move /mnt/userdirs /homeCopy to Clipboard Copied! Toggle word wrap Toggle overflow findmnt ls old-directory ls new-directory

$ findmnt $ ls old-directory $ ls new-directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow

16.5.

umount mount-point

# umount mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow umount device

# umount deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

umount: /run/media/user/FlashDrive: target is busy.

umount: /run/media/user/FlashDrive: target is busy.Copy to Clipboard Copied! Toggle word wrap Toggle overflow fuser --mount /run/media/user/FlashDrive /run/media/user/FlashDrive: 18351

$ fuser --mount /run/media/user/FlashDrive /run/media/user/FlashDrive: 18351Copy to Clipboard Copied! Toggle word wrap Toggle overflow

16.6.

16.7.

mount --options option1,option2,option3 device mount-point

# mount --options option1,option2,option3 device mount-point|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

第 17 章

17.2.

mount --bind original-dir original-dir

# mount --bind original-dir original-dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount --make-private original-dir

# mount --make-private original-dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount --bind original-dir duplicate-dir

# mount --bind original-dir duplicate-dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow

例 17.1.

mount --bind /media /media

# mount --bind /media /mediaCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount --make-private /media

# mount --make-private /mediaCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount --bind /media /mnt

# mount --bind /media /mntCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount /dev/cdrom /media/cdrom ls /media/cdrom EFI GPL isolinux LiveOS ls /mnt/cdrom #

# mount /dev/cdrom /media/cdrom # ls /media/cdrom EFI GPL isolinux LiveOS # ls /mnt/cdrom #Copy to Clipboard Copied! Toggle word wrap Toggle overflow mount /dev/sdc1 /mnt/flashdisk ls /media/flashdisk ls /mnt/flashdisk en-US publican.cfg

# mount /dev/sdc1 /mnt/flashdisk # ls /media/flashdisk # ls /mnt/flashdisk en-US publican.cfgCopy to Clipboard Copied! Toggle word wrap Toggle overflow

17.4.

mount --bind original-dir original-dir

# mount --bind original-dir original-dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount --make-shared original-dir

# mount --make-shared original-dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount --bind original-dir duplicate-dir mount --make-slave duplicate-dir

# mount --bind original-dir duplicate-dir # mount --make-slave duplicate-dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow

例 17.3.

mount --bind /media /media

# mount --bind /media /mediaCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount --make-shared /media

# mount --make-shared /mediaCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount --bind /media /mnt mount --make-slave /mnt

# mount --bind /media /mnt # mount --make-slave /mntCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount /dev/cdrom /media/cdrom ls /media/cdrom EFI GPL isolinux LiveOS ls /mnt/cdrom EFI GPL isolinux LiveOS

# mount /dev/cdrom /media/cdrom # ls /media/cdrom EFI GPL isolinux LiveOS # ls /mnt/cdrom EFI GPL isolinux LiveOSCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount /dev/sdc1 /mnt/flashdisk ls /media/flashdisk ls /mnt/flashdisk en-US publican.cfg

# mount /dev/sdc1 /mnt/flashdisk # ls /media/flashdisk # ls /mnt/flashdisk en-US publican.cfgCopy to Clipboard Copied! Toggle word wrap Toggle overflow

17.5.

mount --bind mount-point mount-point mount --make-unbindable mount-point

# mount --bind mount-point mount-point # mount --make-unbindable mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow

例 17.4.

mount --bind /media /media mount --make-unbindable /media

# mount --bind /media /media # mount --make-unbindable /mediaCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 18 章

18.1.

例 18.1.

|

|

|

|

|

|

|

18.2.

lsblk --fs storage-device

$ lsblk --fs storage-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例 18.2.

lsblk --fs /dev/sda1 NAME FSTYPE LABEL UUID MOUNTPOINT sda1 xfs Boot ea74bbec-536d-490c-b8d9-5b40bbd7545b /boot

$ lsblk --fs /dev/sda1 NAME FSTYPE LABEL UUID MOUNTPOINT sda1 xfs Boot ea74bbec-536d-490c-b8d9-5b40bbd7545b /bootCopy to Clipboard Copied! Toggle word wrap Toggle overflow mkdir --parents mount-point

# mkdir --parents mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例 18.3.

UUID=ea74bbec-536d-490c-b8d9-5b40bbd7545b /boot xfs defaults 0 0

UUID=ea74bbec-536d-490c-b8d9-5b40bbd7545b /boot xfs defaults 0 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl daemon-reload

# systemctl daemon-reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount mount-point

# mount mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 19 章

19.1.

19.2.

mount-point map-name options

mount-point map-name options

例 19.1.

/mnt/data /etc/auto.data

/mnt/data /etc/auto.data

mount-point options location

mount-point options location

例 19.2.

payroll -fstype=nfs4 personnel:/exports/payroll sales -fstype=xfs :/dev/hda4

payroll -fstype=nfs4 personnel:/exports/payroll

sales -fstype=xfs :/dev/hda4

19.3.

yum install autofs

# yum install autofsCopy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl enable --now autofs

# systemctl enable --now autofsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

systemctl reload autofs.service

# systemctl reload autofs.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow ls automounted-directory

# ls automounted-directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow

19.4.

/home /etc/auto.home

/home /etc/auto.homeCopy to Clipboard Copied! Toggle word wrap Toggle overflow * -fstype=nfs,rw,sync host.example.com:/home/&

* -fstype=nfs,rw,sync host.example.com:/home/&Copy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl reload autofs

# systemctl reload autofsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

19.5.

例 19.3.

automount: files nis

automount: files nisCopy to Clipboard Copied! Toggle word wrap Toggle overflow +auto.master

+auto.masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow /home auto.home

/home auto.homeCopy to Clipboard Copied! Toggle word wrap Toggle overflow beth fileserver.example.com:/export/home/beth joe fileserver.example.com:/export/home/joe * fileserver.example.com:/export/home/&

beth fileserver.example.com:/export/home/beth joe fileserver.example.com:/export/home/joe * fileserver.example.com:/export/home/&Copy to Clipboard Copied! Toggle word wrap Toggle overflow BROWSE_MODE="yes"

BROWSE_MODE="yes"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

例 19.4.

/home /etc/auto.home +auto.master

/home /etc/auto.home +auto.masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow * host.example.com:/export/home/&

* host.example.com:/export/home/&Copy to Clipboard Copied! Toggle word wrap Toggle overflow

例 19.5.

mydir someserver:/export/mydir +auto.home

mydir someserver:/export/mydir +auto.homeCopy to Clipboard Copied! Toggle word wrap Toggle overflow ls /home beth joe mydir

$ ls /home beth joe mydirCopy to Clipboard Copied! Toggle word wrap Toggle overflow

19.6.

例 19.6.

DEFAULT_MAP_OBJECT_CLASS="automountMap" DEFAULT_ENTRY_OBJECT_CLASS="automount" DEFAULT_MAP_ATTRIBUTE="automountMapName" DEFAULT_ENTRY_ATTRIBUTE="automountKey" DEFAULT_VALUE_ATTRIBUTE="automountInformation"

DEFAULT_MAP_OBJECT_CLASS="automountMap" DEFAULT_ENTRY_OBJECT_CLASS="automount" DEFAULT_MAP_ATTRIBUTE="automountMapName" DEFAULT_ENTRY_ATTRIBUTE="automountKey" DEFAULT_VALUE_ATTRIBUTE="automountInformation"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例 19.7.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

19.7.

/dev/disk/by-id/da875760-edb9-4b82-99dc-5f4b1ff2e5f4 /mount/point xfs defaults 0 0

/dev/disk/by-id/da875760-edb9-4b82-99dc-5f4b1ff2e5f4 /mount/point xfs defaults 0 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl daemon-reload

# systemctl daemon-reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl start mount-point.automount

# systemctl start mount-point.automountCopy to Clipboard Copied! Toggle word wrap Toggle overflow

systemctl status mount-point.automount

# systemctl status mount-point.automountCopy to Clipboard Copied! Toggle word wrap Toggle overflow ls /mount/point

# ls /mount/pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow

19.8.

mount-point.mount [Mount] What=/dev/disk/by-uuid/f5755511-a714-44c1-a123-cfde0e4ac688 Where=/mount/point Type=xfs

mount-point.mount [Mount] What=/dev/disk/by-uuid/f5755511-a714-44c1-a123-cfde0e4ac688 Where=/mount/point Type=xfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow [Automount] Where=/mount/point [Install] WantedBy=multi-user.target

[Automount] Where=/mount/point [Install] WantedBy=multi-user.targetCopy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl daemon-reload

# systemctl daemon-reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl enable --now mount-point.automount

# systemctl enable --now mount-point.automountCopy to Clipboard Copied! Toggle word wrap Toggle overflow

systemctl status mount-point.automount

# systemctl status mount-point.automountCopy to Clipboard Copied! Toggle word wrap Toggle overflow ls /mount/point

# ls /mount/pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 20 章

20.1.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意ldap_uri = "ldap:///dc=example,dc=com"

ldap_uri = "ldap:///dc=example,dc=com"Copy to Clipboard Copied! Toggle word wrap Toggle overflow ldap_uri = "ldap://ipa.example.com" search_base = "cn=location,cn=automount,dc=example,dc=com"

ldap_uri = "ldap://ipa.example.com" search_base = "cn=location,cn=automount,dc=example,dc=com"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow

20.2.

vim /etc/sssd/sssd.conf

# vim /etc/sssd/sssd.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow [sssd] domains = ldap services = nss,pam,autofs

[sssd] domains = ldap services = nss,pam,autofsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow [domain/EXAMPLE] ldap_search_base = "dc=example,dc=com" ldap_autofs_search_base = "ou=automount,dc=example,dc=com"

[domain/EXAMPLE] ldap_search_base = "dc=example,dc=com" ldap_autofs_search_base = "ou=automount,dc=example,dc=com"Copy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl restart sssd.service

# systemctl restart sssd.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow automount: sss files

automount: sss filesCopy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl restart autofs.service

# systemctl restart autofs.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow ls /home/userName

# ls /home/userNameCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 21 章

21.1.

copy-method path

copy-method path

empty /tmp

empty /tmpCopy to Clipboard Copied! Toggle word wrap Toggle overflow dirs /var/run

dirs /var/runCopy to Clipboard Copied! Toggle word wrap Toggle overflow files /etc/resolv.conf

files /etc/resolv.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow

21.2.

READONLY=yes

READONLY=yesCopy to Clipboard Copied! Toggle word wrap Toggle overflow /dev/mapper/luks-c376919e... / xfs x-systemd.device-timeout=0,ro 1 1

/dev/mapper/luks-c376919e... / xfs x-systemd.device-timeout=0,ro 1 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow grubby --update-kernel=ALL --args="ro"

# grubby --update-kernel=ALL --args="ro"Copy to Clipboard Copied! Toggle word wrap Toggle overflow grubby --update-kernel=ALL --remove-args="rw"

# grubby --update-kernel=ALL --remove-args="rw"Copy to Clipboard Copied! Toggle word wrap Toggle overflow files /etc/example/file

files /etc/example/fileCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要

mount -o remount,rw /

# mount -o remount,rw /Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 22 章

22.1.

22.2.

22.3.

22.4.

mount -o uquota /dev/xvdb1 /xfs

# mount -o uquota /dev/xvdb1 /xfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount -o gquota /dev/xvdb1 /xfs

# mount -o gquota /dev/xvdb1 /xfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount -o pquota /dev/xvdb1 /xfs

# mount -o pquota /dev/xvdb1 /xfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow vim /etc/fstab /dev/xvdb1 /xfs xfs rw,quota 0 0 /dev/xvdb1 /xfs xfs rw,gquota 0 0 /dev/xvdb1 /xfs xfs rw,prjquota 0 0

# vim /etc/fstab /dev/xvdb1 /xfs xfs rw,quota 0 0 /dev/xvdb1 /xfs xfs rw,gquota 0 0 /dev/xvdb1 /xfs xfs rw,prjquota 0 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

22.5.

xfs_quota

# xfs_quotaCopy to Clipboard Copied! Toggle word wrap Toggle overflow xfs_quota> quota username

xfs_quota> quota usernameCopy to Clipboard Copied! Toggle word wrap Toggle overflow xfs_quota> df

xfs_quota> dfCopy to Clipboard Copied! Toggle word wrap Toggle overflow xfs_quota> help

xfs_quota> helpCopy to Clipboard Copied! Toggle word wrap Toggle overflow xfs_quota> q

xfs_quota> qCopy to Clipboard Copied! Toggle word wrap Toggle overflow

22.6.

xfs_quota -x /path

# xfs_quota -x /pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow xfs_quota> report /path

xfs_quota> report /pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow xfs_quota> limit isoft=500m ihard=700m user

xfs_quota> limit isoft=500m ihard=700m userCopy to Clipboard Copied! Toggle word wrap Toggle overflow xfs_quota -x -c 'limit isoft=500 ihard=700 john' /home/

# xfs_quota -x -c 'limit isoft=500 ihard=700 john' /home/Copy to Clipboard Copied! Toggle word wrap Toggle overflow xfs_quota> help

xfs_quota> helpCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

22.7.

echo 11:/var/log >> /etc/projects

# echo 11:/var/log >> /etc/projectsCopy to Clipboard Copied! Toggle word wrap Toggle overflow echo logfiles:11 >> /etc/projid

# echo logfiles:11 >> /etc/projidCopy to Clipboard Copied! Toggle word wrap Toggle overflow xfs_quota -x -c 'project -s logfiles' /var

# xfs_quota -x -c 'project -s logfiles' /varCopy to Clipboard Copied! Toggle word wrap Toggle overflow xfs_quota -x -c 'limit -p bhard=1g logfiles' /var

# xfs_quota -x -c 'limit -p bhard=1g logfiles' /varCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 23 章

23.1.

yum install quota

# yum install quotaCopy to Clipboard Copied! Toggle word wrap Toggle overflow

23.2.

mkfs.ext4 -O quota /dev/sda

# mkfs.ext4 -O quota /dev/sdaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意mkfs.ext4 -O quota -E quotatype=usrquota:grpquota:prjquota /dev/sda

# mkfs.ext4 -O quota -E quotatype=usrquota:grpquota:prjquota /dev/sdaCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount /dev/sda

# mount /dev/sdaCopy to Clipboard Copied! Toggle word wrap Toggle overflow

23.3.

umount /dev/sda

# umount /dev/sdaCopy to Clipboard Copied! Toggle word wrap Toggle overflow tune2fs -O quota /dev/sda

# tune2fs -O quota /dev/sdaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意tune2fs -Q usrquota,grpquota,prjquota /dev/sda

# tune2fs -Q usrquota,grpquota,prjquota /dev/sdaCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount /dev/sda

# mount /dev/sdaCopy to Clipboard Copied! Toggle word wrap Toggle overflow

23.4.

mount /dev/sda /mnt

# mount /dev/sda /mntCopy to Clipboard Copied! Toggle word wrap Toggle overflow quotaon /mnt

# quotaon /mntCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意mount -o usrquota,grpquota,prjquota /dev/sda /mnt

# mount -o usrquota,grpquota,prjquota /dev/sda /mntCopy to Clipboard Copied! Toggle word wrap Toggle overflow quotaon -vaugP

# quotaon -vaugPCopy to Clipboard Copied! Toggle word wrap Toggle overflow quotaon -vugP /home

# quotaon -vugP /homeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

23.5.

edquota username

# edquota usernameCopy to Clipboard Copied! Toggle word wrap Toggle overflow Disk quotas for user testuser (uid 501): Filesystem blocks soft hard inodes soft hard /dev/sda 44043 0 0 37418 0 0

Disk quotas for user testuser (uid 501): Filesystem blocks soft hard inodes soft hard /dev/sda 44043 0 0 37418 0 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow Disk quotas for user testuser (uid 501): Filesystem blocks soft hard inodes soft hard /dev/sda 44043 50000 55000 37418 0 0

Disk quotas for user testuser (uid 501): Filesystem blocks soft hard inodes soft hard /dev/sda 44043 50000 55000 37418 0 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

quota -v testuser Disk quotas for user testuser: Filesystem blocks quota limit grace files quota limit grace /dev/sda 1000* 1000 1000 0 0 0

# quota -v testuser Disk quotas for user testuser: Filesystem blocks quota limit grace files quota limit grace /dev/sda 1000* 1000 1000 0 0 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

23.6.

edquota -g groupname

# edquota -g groupnameCopy to Clipboard Copied! Toggle word wrap Toggle overflow edquota -g devel

# edquota -g develCopy to Clipboard Copied! Toggle word wrap Toggle overflow Disk quotas for group devel (gid 505): Filesystem blocks soft hard inodes soft hard /dev/sda 440400 0 0 37418 0 0

Disk quotas for group devel (gid 505): Filesystem blocks soft hard inodes soft hard /dev/sda 440400 0 0 37418 0 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

quota -vg groupname

# quota -vg groupnameCopy to Clipboard Copied! Toggle word wrap Toggle overflow

23.7.

echo 11:/var/log >> /etc/projects

# echo 11:/var/log >> /etc/projectsCopy to Clipboard Copied! Toggle word wrap Toggle overflow echo Logs:11 >> /etc/projid

# echo Logs:11 >> /etc/projidCopy to Clipboard Copied! Toggle word wrap Toggle overflow edquota -P 11

# edquota -P 11Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意

quota -vP 11

# quota -vP 11Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意

23.8.

edquota -t

# edquota -tCopy to Clipboard Copied! Toggle word wrap Toggle overflow

23.9.

quotaoff -vaugP

# quotaoff -vaugPCopy to Clipboard Copied! Toggle word wrap Toggle overflow

23.10.

repquota

# repquotaCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow repquota -augP

# repquota -augPCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 24 章

24.1.

24.2.

fstrim mount-point

# fstrim mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow fstrim --all

# fstrim --allCopy to Clipboard Copied! Toggle word wrap Toggle overflow

fstrim /mnt/non_discard fstrim: /mnt/non_discard: the discard operation is not supported

# fstrim /mnt/non_discard

fstrim: /mnt/non_discard: the discard operation is not supported24.3.

mount -o discard device mount-point

# mount -o discard device mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow

24.4.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

ansible managed-node-01.example.com -m command -a 'findmnt /mnt/data'

# ansible managed-node-01.example.com -m command -a 'findmnt /mnt/data'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

24.5.

systemctl enable --now fstrim.timer Created symlink /etc/systemd/system/timers.target.wants/fstrim.timer → /usr/lib/systemd/system/fstrim.timer.

# systemctl enable --now fstrim.timer Created symlink /etc/systemd/system/timers.target.wants/fstrim.timer → /usr/lib/systemd/system/fstrim.timer.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 25 章

25.1.

- 重要

25.2.

25.3.

dnf install stratisd stratis-cli

# dnf install stratisd stratis-cliCopy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl enable --now stratisd

# systemctl enable --now stratisdCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

25.4.

wipefs --all block-device

# wipefs --all block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow stratis pool create my-pool block-device

# stratis pool create my-pool block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow stratis pool create my-pool block-device-1 block-device-2

# stratis pool create my-pool block-device-1 block-device-2Copy to Clipboard Copied! Toggle word wrap Toggle overflow

stratis pool list

# stratis pool listCopy to Clipboard Copied! Toggle word wrap Toggle overflow

25.5.

25.6.

wipefs --all block-device

# wipefs --all block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow stratis key set --capture-key key-description

# stratis key set --capture-key key-descriptionCopy to Clipboard Copied! Toggle word wrap Toggle overflow stratis pool create --key-desc key-description my-pool block-device

# stratis pool create --key-desc key-description my-pool block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow stratis pool create --key-desc key-description my-pool block-device-1 block-device-2

# stratis pool create --key-desc key-description my-pool block-device-1 block-device-2Copy to Clipboard Copied! Toggle word wrap Toggle overflow

stratis pool list

# stratis pool listCopy to Clipboard Copied! Toggle word wrap Toggle overflow

25.7.

25.8.

25.9.

stratis pool create pool-name /dev/sdb

# stratis pool create pool-name /dev/sdbCopy to Clipboard Copied! Toggle word wrap Toggle overflow stratis pool overprovision pool-name <yes|no>

# stratis pool overprovision pool-name <yes|no>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

stratis pool list Name Total Physical Properties UUID Alerts pool-name 1.42 TiB / 23.96 MiB / 1.42 TiB ~Ca,~Cr,~Op cb7cb4d8-9322-4ac4-a6fd-eb7ae9e1e540

# stratis pool list Name Total Physical Properties UUID Alerts pool-name 1.42 TiB / 23.96 MiB / 1.42 TiB ~Ca,~Cr,~Op cb7cb4d8-9322-4ac4-a6fd-eb7ae9e1e540Copy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow

25.10.

stratis pool bind nbde --trust-url my-pool tang-server

# stratis pool bind nbde --trust-url my-pool tang-serverCopy to Clipboard Copied! Toggle word wrap Toggle overflow

25.11.

stratis pool bind tpm my-pool

# stratis pool bind tpm my-poolCopy to Clipboard Copied! Toggle word wrap Toggle overflow

25.12.

stratis key set --capture-key key-description

# stratis key set --capture-key key-descriptionCopy to Clipboard Copied! Toggle word wrap Toggle overflow stratis pool list

# stratis pool listCopy to Clipboard Copied! Toggle word wrap Toggle overflow

25.13.

stratis pool unbind clevis my-pool

# stratis pool unbind clevis my-poolCopy to Clipboard Copied! Toggle word wrap Toggle overflow

25.14.

stratis pool stop --name pool-name

# stratis pool stop --name pool-nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow stratis pool start --unlock-method <keyring|clevis> --name pool-name

# stratis pool start --unlock-method <keyring|clevis> --name pool-nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意

stratis pool list

# stratis pool listCopy to Clipboard Copied! Toggle word wrap Toggle overflow stratis pool list --stopped

# stratis pool list --stoppedCopy to Clipboard Copied! Toggle word wrap Toggle overflow stratis pool list --stopped --uuid UUID

# stratis pool list --stopped --uuid UUIDCopy to Clipboard Copied! Toggle word wrap Toggle overflow

25.15.

stratis filesystem create --size number-and-unit my-pool my-fs

# stratis filesystem create --size number-and-unit my-pool my-fsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例 25.1.

stratis filesystem create --size 10GiB pool1 filesystem1

# stratis filesystem create --size 10GiB pool1 filesystem1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

stratis fs list my-pool

# stratis fs list my-poolCopy to Clipboard Copied! Toggle word wrap Toggle overflow

25.16.

25.17.

mount /dev/stratis/my-pool/my-fs mount-point

# mount /dev/stratis/my-pool/my-fs mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow

25.18.

/dev/stratis/my-pool/my-fs mount-point xfs defaults,x-systemd.requires=stratis-fstab-setup@pool-uuid.service,x-systemd.after=stratis-fstab-setup@pool-uuid.service dump-value fsck_value

/dev/stratis/my-pool/my-fs mount-point xfs defaults,x-systemd.requires=stratis-fstab-setup@pool-uuid.service,x-systemd.after=stratis-fstab-setup@pool-uuid.service dump-value fsck_valueCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 26 章

26.1.

stratis pool add-data my-pool device-1 device-2 device-n

# stratis pool add-data my-pool device-1 device-2 device-nCopy to Clipboard Copied! Toggle word wrap Toggle overflow

26.2.

第 27 章

27.1.

stratis blockdev Pool Name Device Node Physical Size State Tier my-pool /dev/sdb 9.10 TiB In-use Data

# stratis blockdev Pool Name Device Node Physical Size State Tier my-pool /dev/sdb 9.10 TiB In-use DataCopy to Clipboard Copied! Toggle word wrap Toggle overflow stratis pool Name Total Physical Size Total Physical Used my-pool 9.10 TiB 598 MiB

# stratis pool Name Total Physical Size Total Physical Used my-pool 9.10 TiB 598 MiBCopy to Clipboard Copied! Toggle word wrap Toggle overflow stratis filesystem Pool Name Name Used Created Device my-pool my-fs 546 MiB Nov 08 2018 08:03 /dev/stratis/my-pool/my-fs

# stratis filesystem Pool Name Name Used Created Device my-pool my-fs 546 MiB Nov 08 2018 08:03 /dev/stratis/my-pool/my-fsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

27.2.

第 28 章

28.1.

28.2.

stratis fs snapshot my-pool my-fs my-fs-snapshot

# stratis fs snapshot my-pool my-fs my-fs-snapshotCopy to Clipboard Copied! Toggle word wrap Toggle overflow

28.3.

mount /dev/stratis/my-pool/my-fs-snapshot mount-point

# mount /dev/stratis/my-pool/my-fs-snapshot mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow

28.4.

stratis filesystem snapshot my-pool my-fs my-fs-backup

# stratis filesystem snapshot my-pool my-fs my-fs-backupCopy to Clipboard Copied! Toggle word wrap Toggle overflow umount /dev/stratis/my-pool/my-fs stratis filesystem destroy my-pool my-fs

# umount /dev/stratis/my-pool/my-fs # stratis filesystem destroy my-pool my-fsCopy to Clipboard Copied! Toggle word wrap Toggle overflow stratis filesystem snapshot my-pool my-fs-snapshot my-fs

# stratis filesystem snapshot my-pool my-fs-snapshot my-fsCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount /dev/stratis/my-pool/my-fs mount-point

# mount /dev/stratis/my-pool/my-fs mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow

28.5.

umount /dev/stratis/my-pool/my-fs-snapshot

# umount /dev/stratis/my-pool/my-fs-snapshotCopy to Clipboard Copied! Toggle word wrap Toggle overflow stratis filesystem destroy my-pool my-fs-snapshot

# stratis filesystem destroy my-pool my-fs-snapshotCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 29 章

29.1.

umount /dev/stratis/my-pool/my-fs

# umount /dev/stratis/my-pool/my-fsCopy to Clipboard Copied! Toggle word wrap Toggle overflow stratis filesystem destroy my-pool my-fs

# stratis filesystem destroy my-pool my-fsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

stratis filesystem list my-pool

# stratis filesystem list my-poolCopy to Clipboard Copied! Toggle word wrap Toggle overflow

29.2.

29.3.

stratis filesystem list my-pool

# stratis filesystem list my-poolCopy to Clipboard Copied! Toggle word wrap Toggle overflow umount /dev/stratis/my-pool/my-fs-1 \ /dev/stratis/my-pool/my-fs-2 \ /dev/stratis/my-pool/my-fs-n# umount /dev/stratis/my-pool/my-fs-1 \ /dev/stratis/my-pool/my-fs-2 \ /dev/stratis/my-pool/my-fs-nCopy to Clipboard Copied! Toggle word wrap Toggle overflow stratis filesystem destroy my-pool my-fs-1 my-fs-2

# stratis filesystem destroy my-pool my-fs-1 my-fs-2Copy to Clipboard Copied! Toggle word wrap Toggle overflow stratis pool destroy my-pool

# stratis pool destroy my-poolCopy to Clipboard Copied! Toggle word wrap Toggle overflow

stratis pool list

# stratis pool listCopy to Clipboard Copied! Toggle word wrap Toggle overflow

29.4.

第 30 章

30.1.

- 注意

30.2.

mkfs.ext3 /dev/block_device

# mkfs.ext3 /dev/block_deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow mkfs.ext3 -E stride=16,stripe-width=64 /dev/block_device

# mkfs.ext3 -E stride=16,stripe-width=64 /dev/block_deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

注意mkfs.ext3 -U UUID /dev/block_device

# mkfs.ext3 -U UUID /dev/block_deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow mkfs.ext3 -L label-name /dev/block_device

# mkfs.ext3 -L label-name /dev/block_deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

blkid

# blkidCopy to Clipboard Copied! Toggle word wrap Toggle overflow

30.3.

mkdir /mount/point

# mkdir /mount/pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount /dev/block_device /mount/point

# mount /dev/block_device /mount/pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow

df -h

# df -hCopy to Clipboard Copied! Toggle word wrap Toggle overflow

30.4.

umount /dev/block_device e2fsck -f /dev/block_device resize2fs /dev/block_device size

# umount /dev/block_device # e2fsck -f /dev/block_device # resize2fs /dev/block_device sizeCopy to Clipboard Copied! Toggle word wrap Toggle overflow resize2fs /mount/device size

# resize2fs /mount/device sizeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意

df -h

# df -hCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 31 章

31.1.

- 注意

31.2.

mkfs.ext4 /dev/block_device

# mkfs.ext4 /dev/block_deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow mkfs.ext4 -E stride=16,stripe-width=64 /dev/block_device

# mkfs.ext4 -E stride=16,stripe-width=64 /dev/block_deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

注意mkfs.ext4 -U UUID /dev/block_device

# mkfs.ext4 -U UUID /dev/block_deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow mkfs.ext4 -L label-name /dev/block_device

# mkfs.ext4 -L label-name /dev/block_deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

blkid

# blkidCopy to Clipboard Copied! Toggle word wrap Toggle overflow

31.3.

mkdir /mount/point

# mkdir /mount/pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow mount /dev/block_device /mount/point

# mount /dev/block_device /mount/pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow

df -h

# df -hCopy to Clipboard Copied! Toggle word wrap Toggle overflow

31.4.

umount /dev/block_device e2fsck -f /dev/block_device resize2fs /dev/block_device size

# umount /dev/block_device # e2fsck -f /dev/block_device # resize2fs /dev/block_device sizeCopy to Clipboard Copied! Toggle word wrap Toggle overflow resize2fs /mount/device size

# resize2fs /mount/device sizeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意

df -h

# df -hCopy to Clipboard Copied! Toggle word wrap Toggle overflow

31.5.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|